文章采集api

文章采集api(一个博客小站来说的收录方式文章目录资源前言)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2022-03-01 01:25

typechoSEO网站收录插件推荐百度提交

文章目录

资源前言

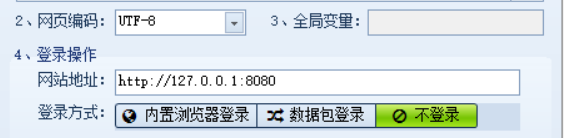

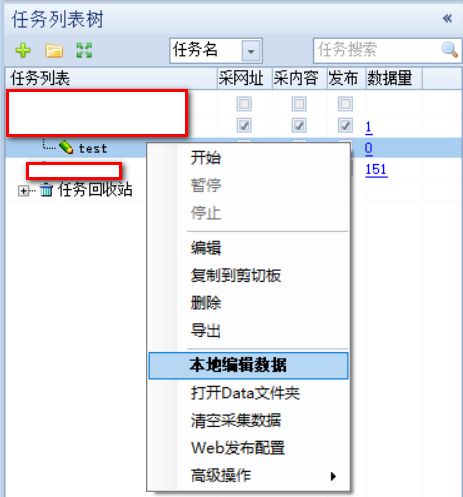

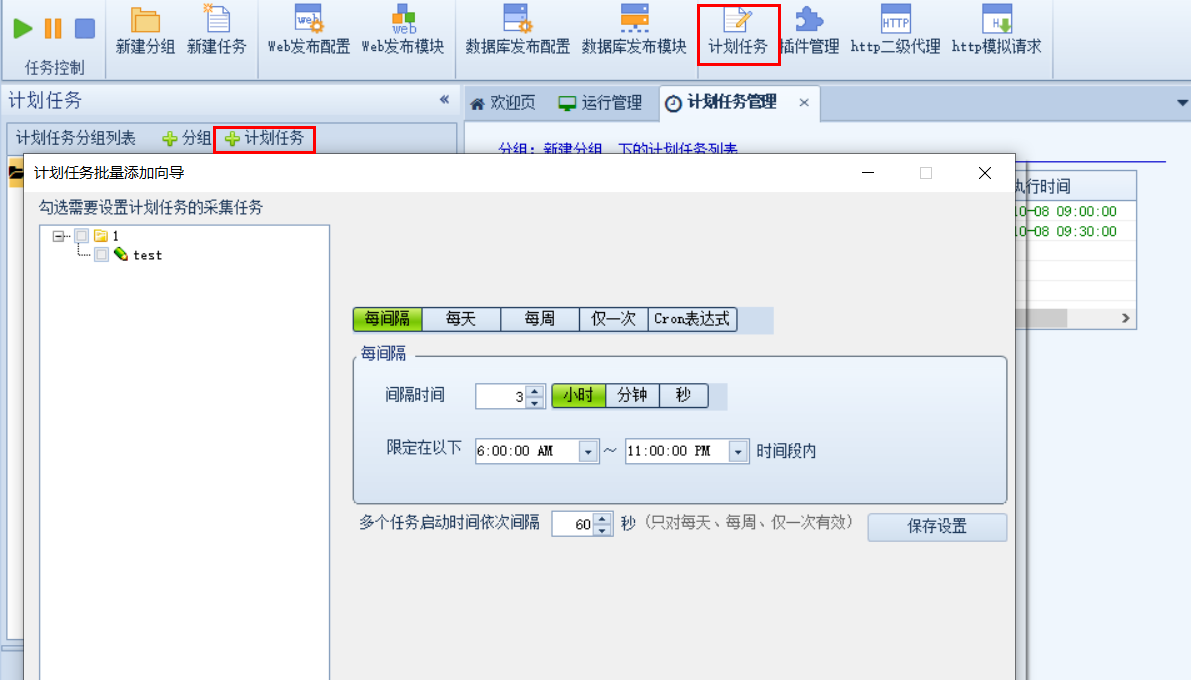

我们在建一个小站点的时候,可能会遇到如何让搜索引擎抓取我们的文章的问题,当然你可以选择不让搜索引擎抓取你的站点。这时候,你就需要SEO(“搜索引擎优化”)。其实涉及的内容很多,但作为我这种小博客网站,没必要。无非就是让你的网站在搜索引擎中的排名更高,让运维来做。在这篇文章中,我主要讲一下我在SEO方面采取的一些做法,主要是百度收录,其他搜索引擎的收录方法类似,大家可以自行搜索理解

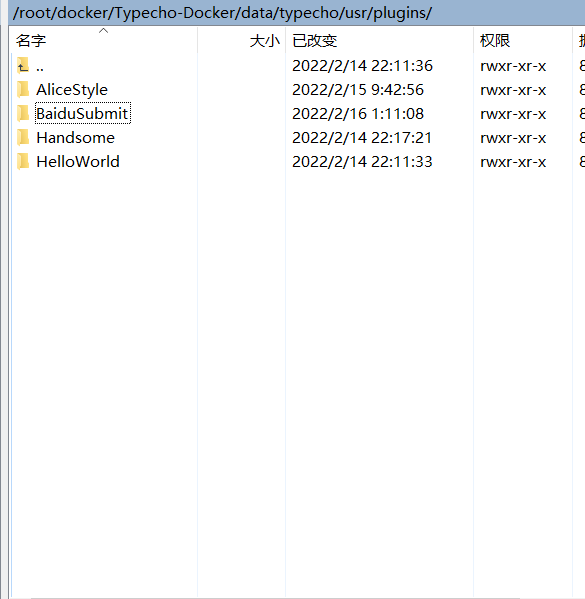

安装

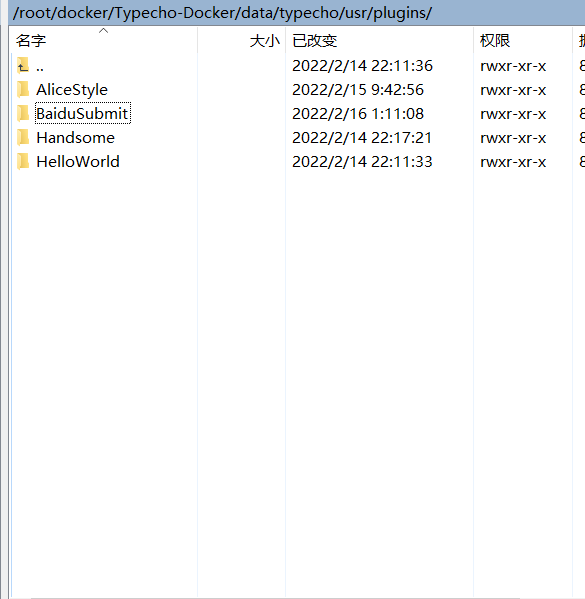

把下载好的插件解压到typecho主目录下的插件目录下,一般是/usr/plugins

然后就可以在typecho的后台插件中看到了

百度站长网站设置

百度搜索引擎提供了站长网站,这样我们就可以主动让百度去收录自己的站点,下面是传送门

门户网站

他提供了几种不同的收录方法,比如quick收录,可以让你主动提供你网站的一些资源,比如sitemap等,缩短搜索引擎爬虫爬取你的时间地点。具体方法有API提交、站点地图、手动提交。这次推荐的插件主要是API提交。

API 提交

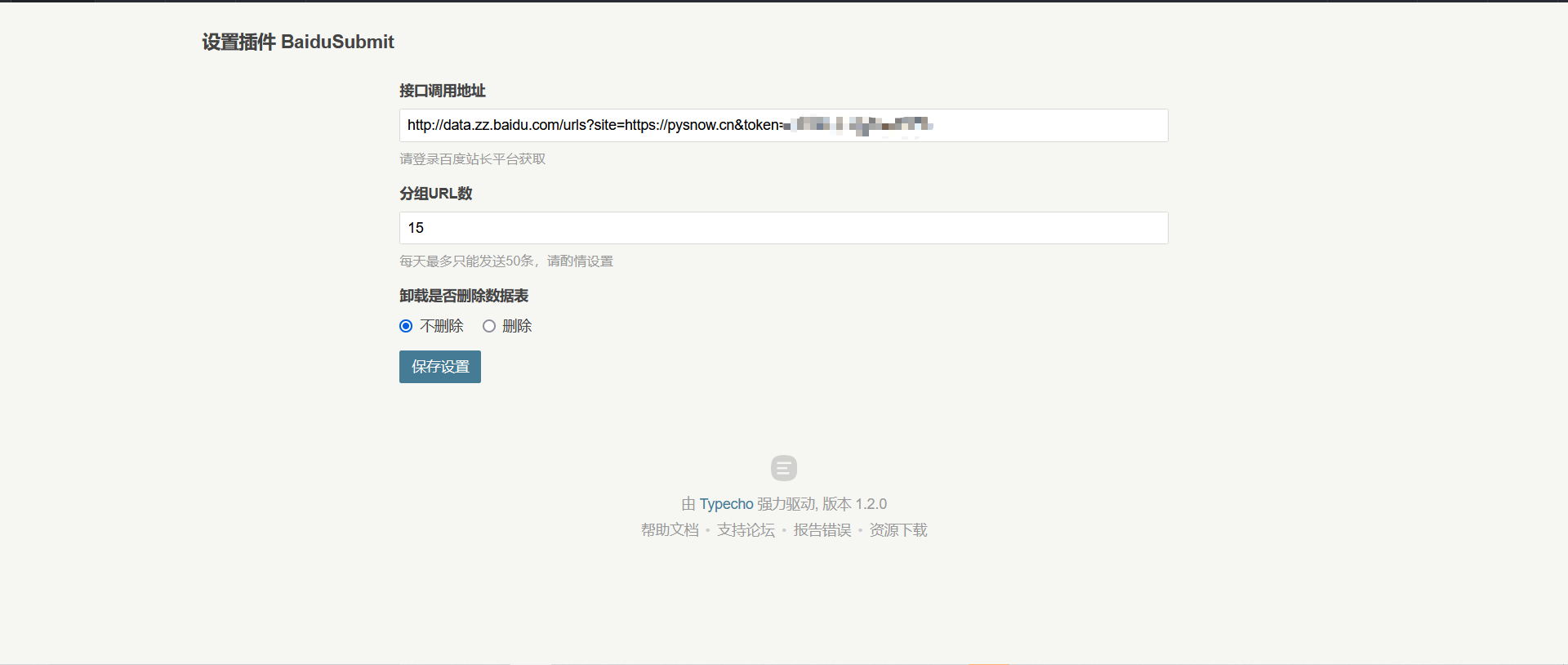

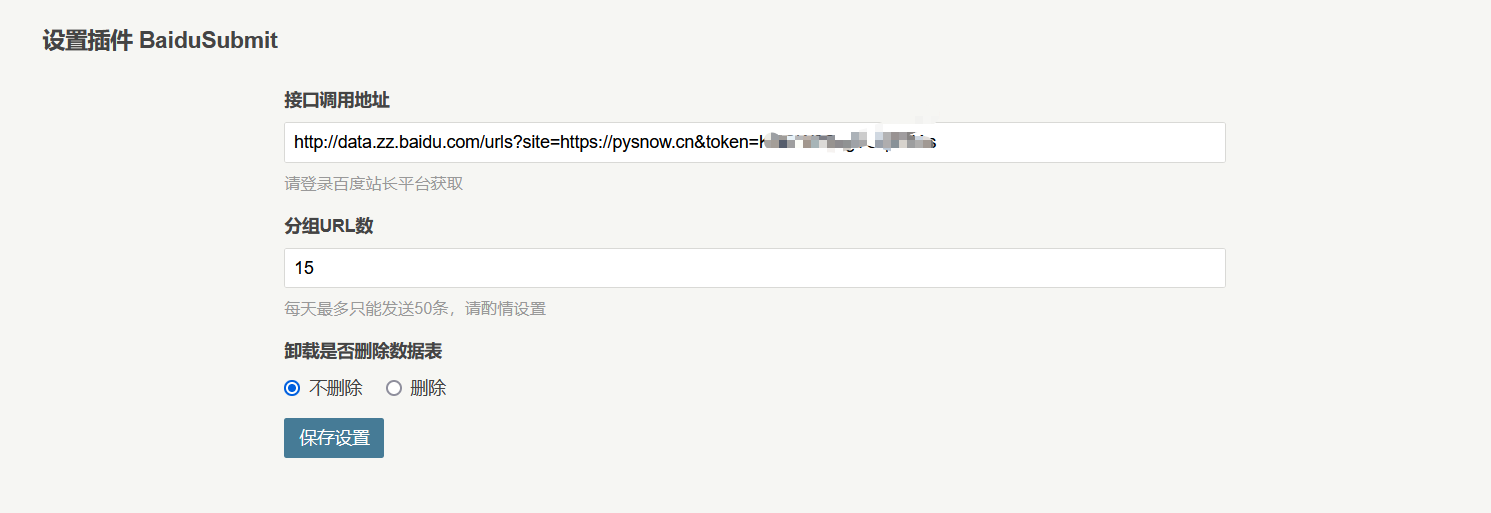

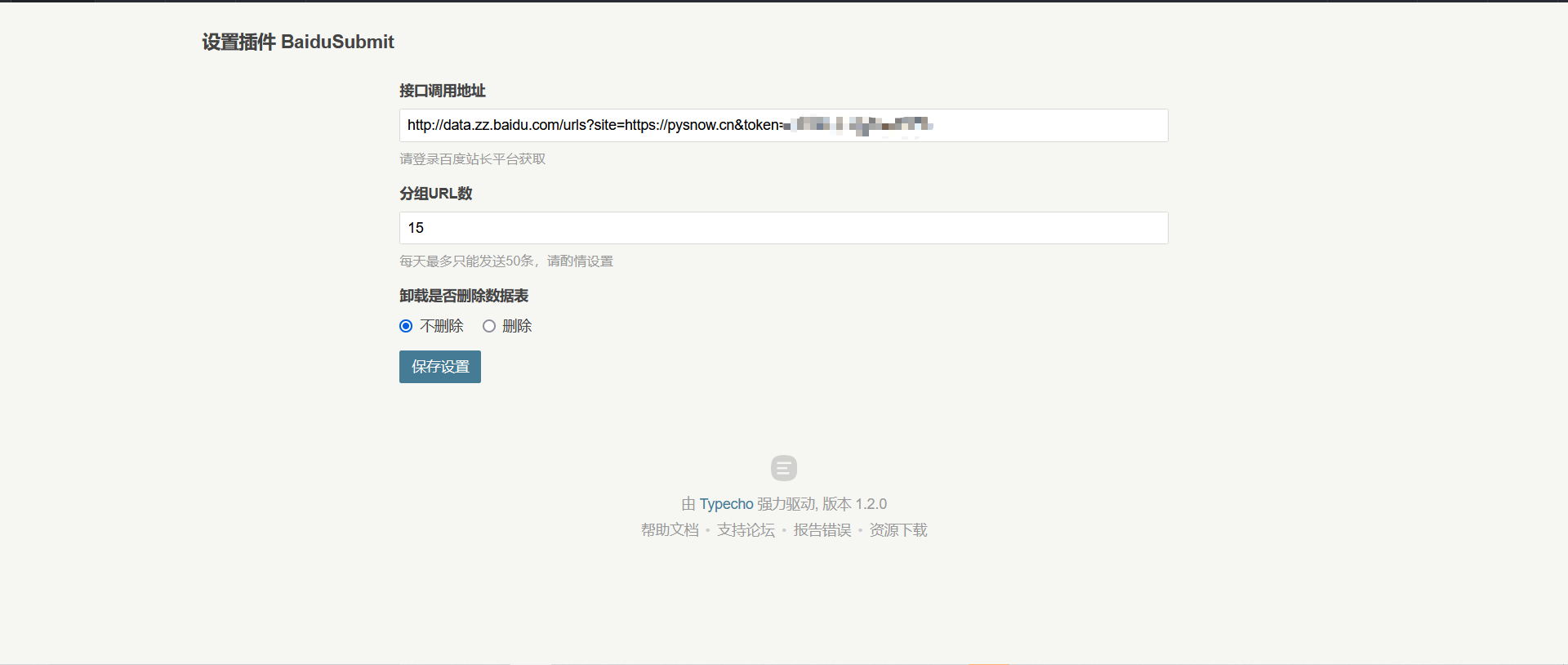

推送接口、推送实例、推送反馈如上所示。我们只需要关注推送接口即可。后两者在实现代码时需要注意。显然,插件作者已经做到了这一点。以下是API接口的样式。

http://data.zz.baidu.com/urls?site={您的站点}&token={验证token,相当于密码}

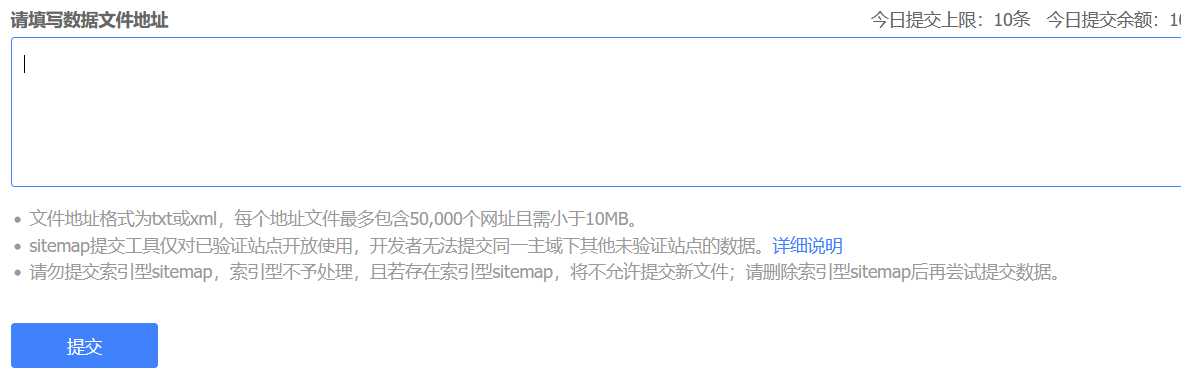

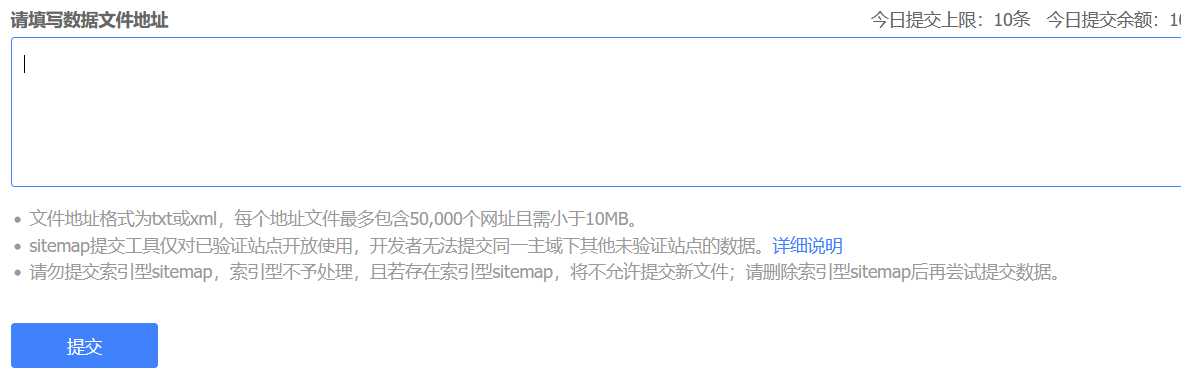

网站地图

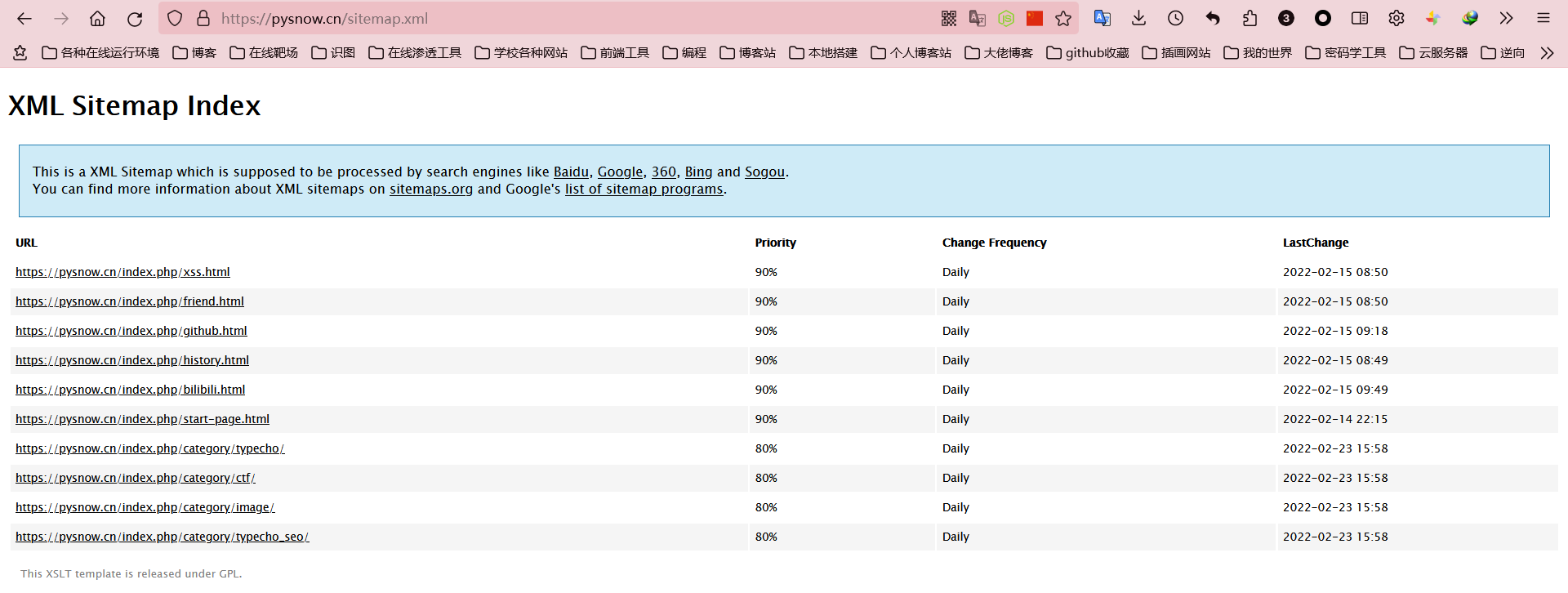

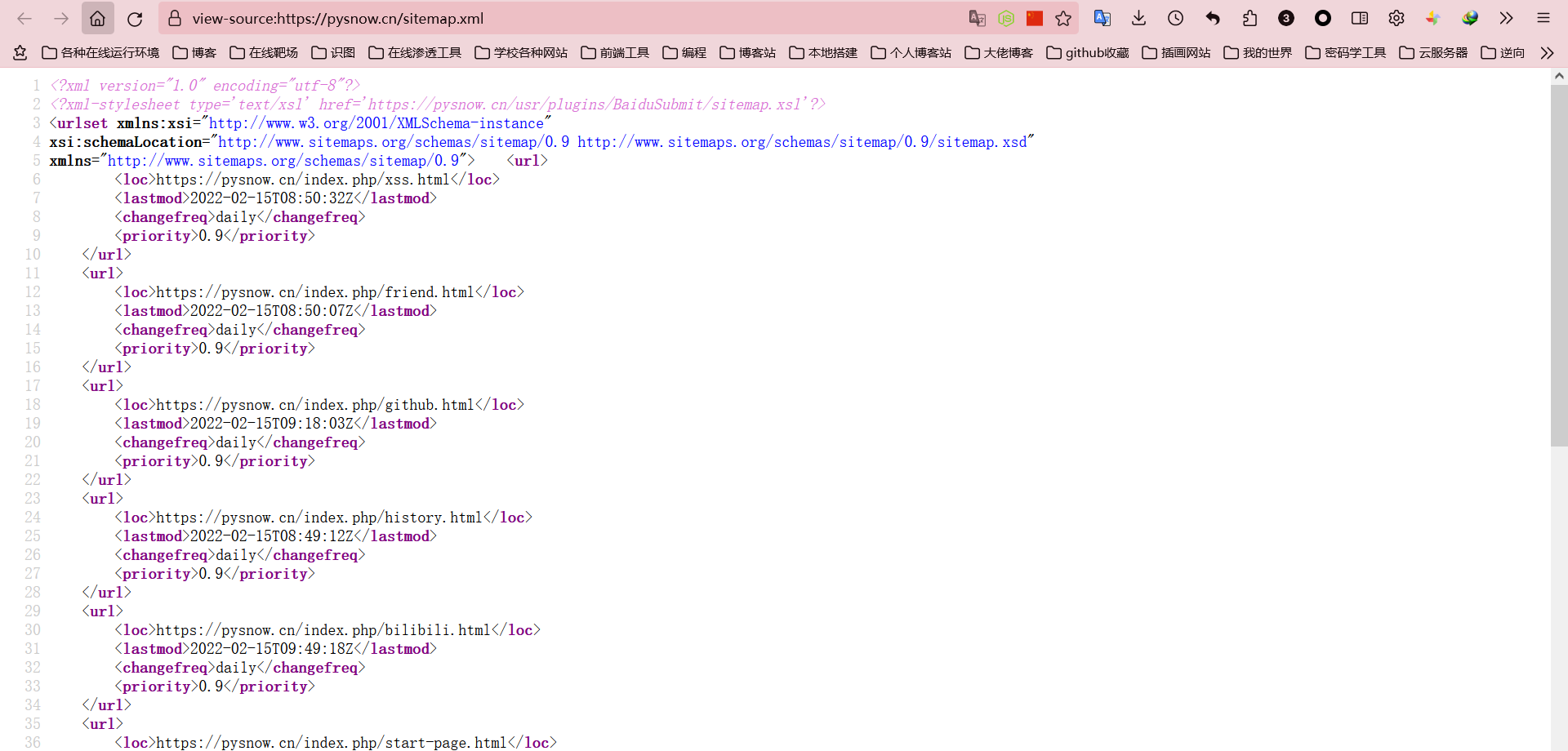

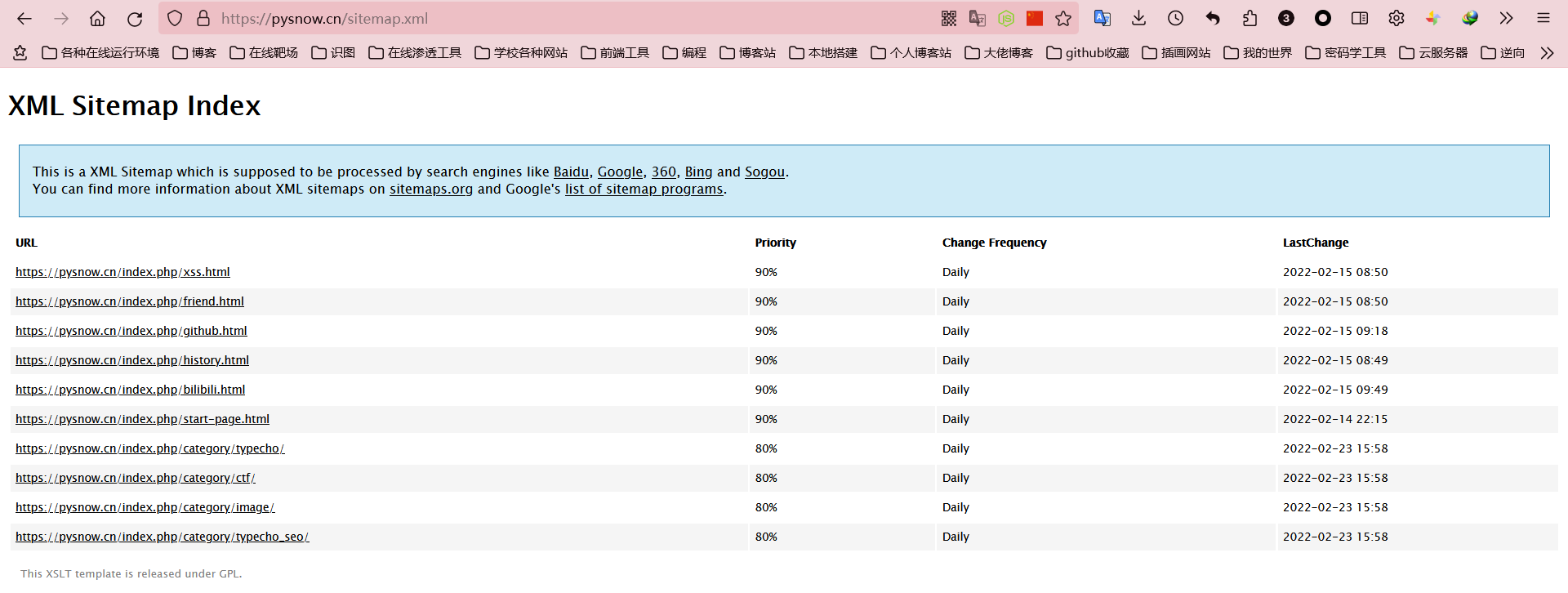

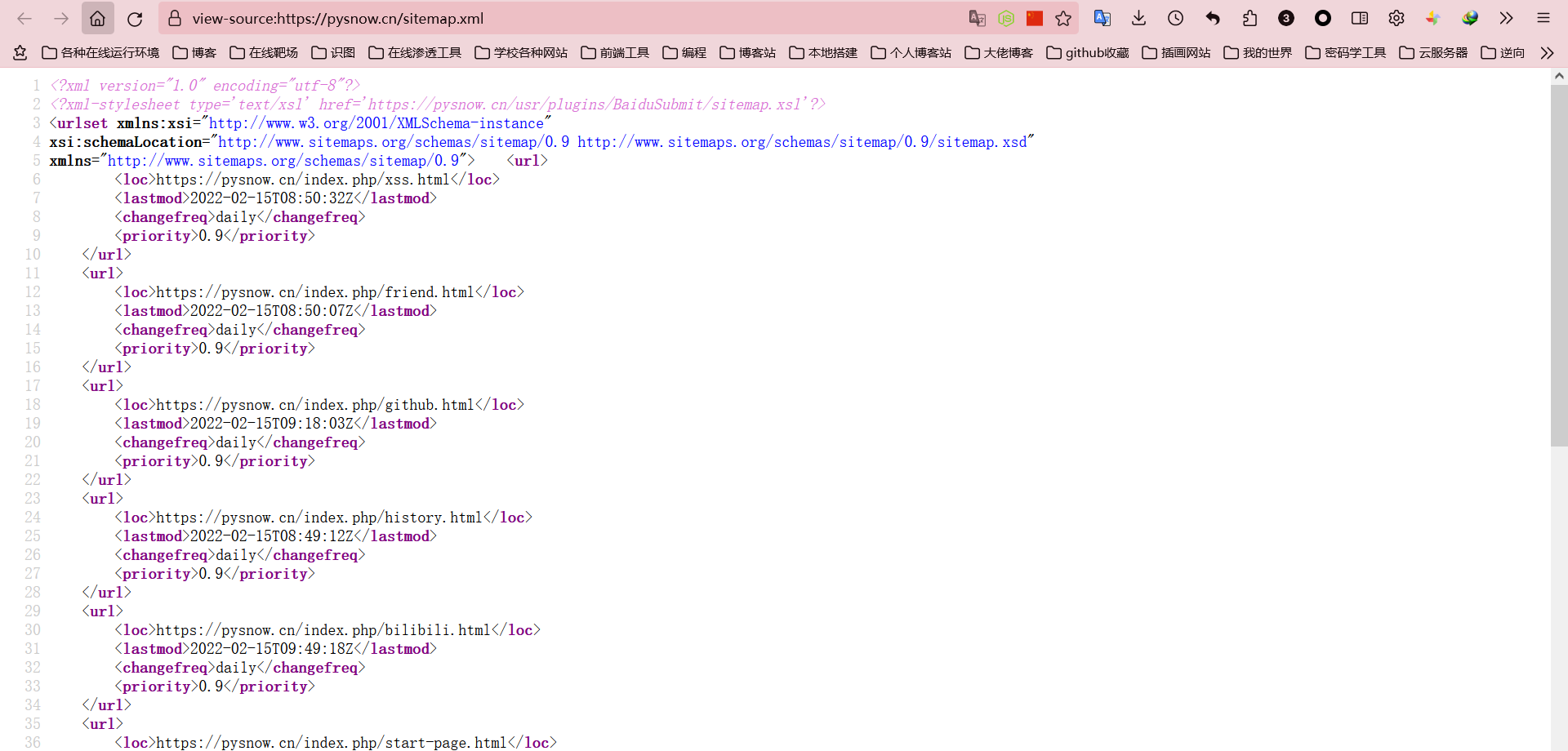

要提交站点地图,您可以使用 txt 或 xml 格式。这里可以直接使用这个插件生成的xml文件,大部分搜索引擎都识别sitemaps(我不知道),比如你可以看一下我的站点自动生成的xml。文档

如果您熟悉 XML,很容易发现大部分站点地图实际上是由这些多个 url 元素组成的。

所以我们可以填写对应的

不仅可以在这里使用站点的路径,而且在这里这样做更方便。另外,这个站点地图一天最多只能推送十次。

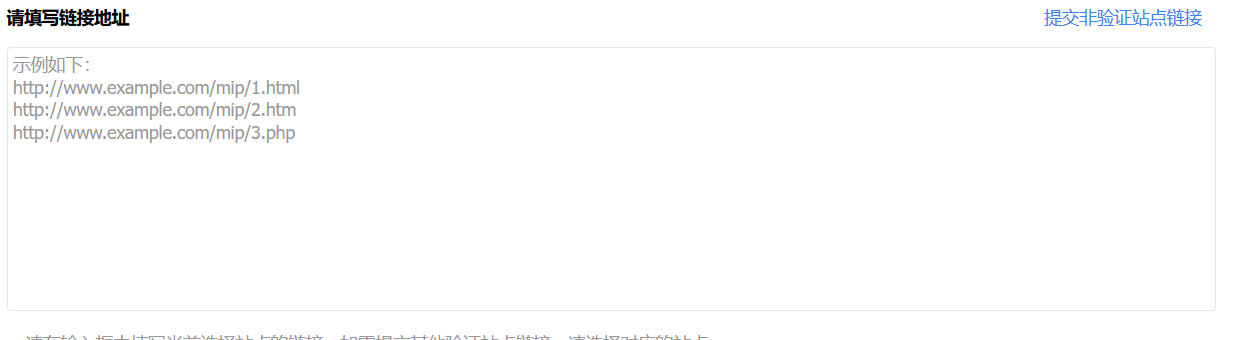

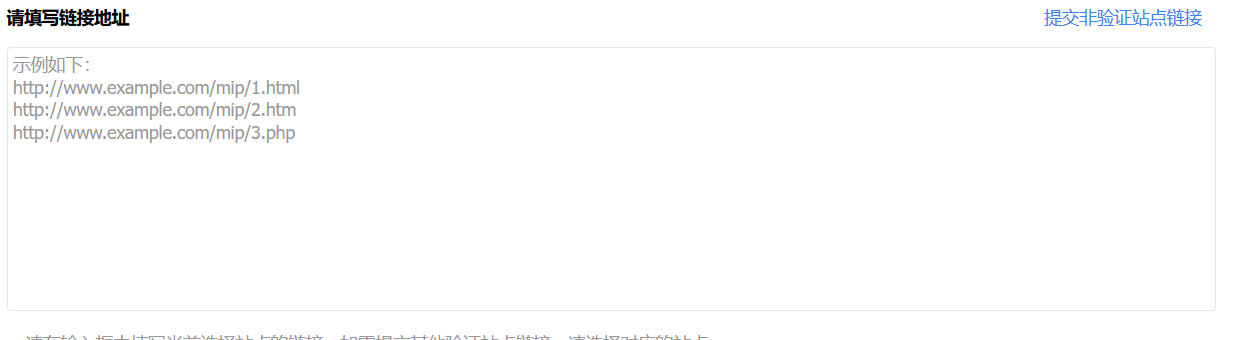

手动提交

也就是提交你网站上写的文章的链接,也就是把sitemap.xml内容中的url链接一个一个提交,这个方法可以保证你的一个文章可以很好收录(不一定,还是看百度吧),自己决定

百度站长其他工具

喜欢什么移动适配,死链接提交可以自己看懂,什么都写清楚了哈哈

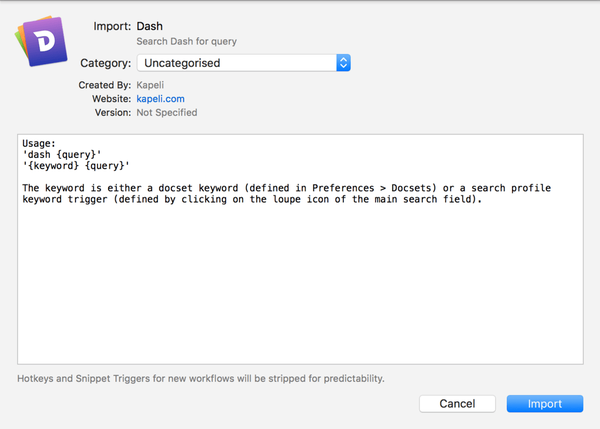

插件介绍功能使用

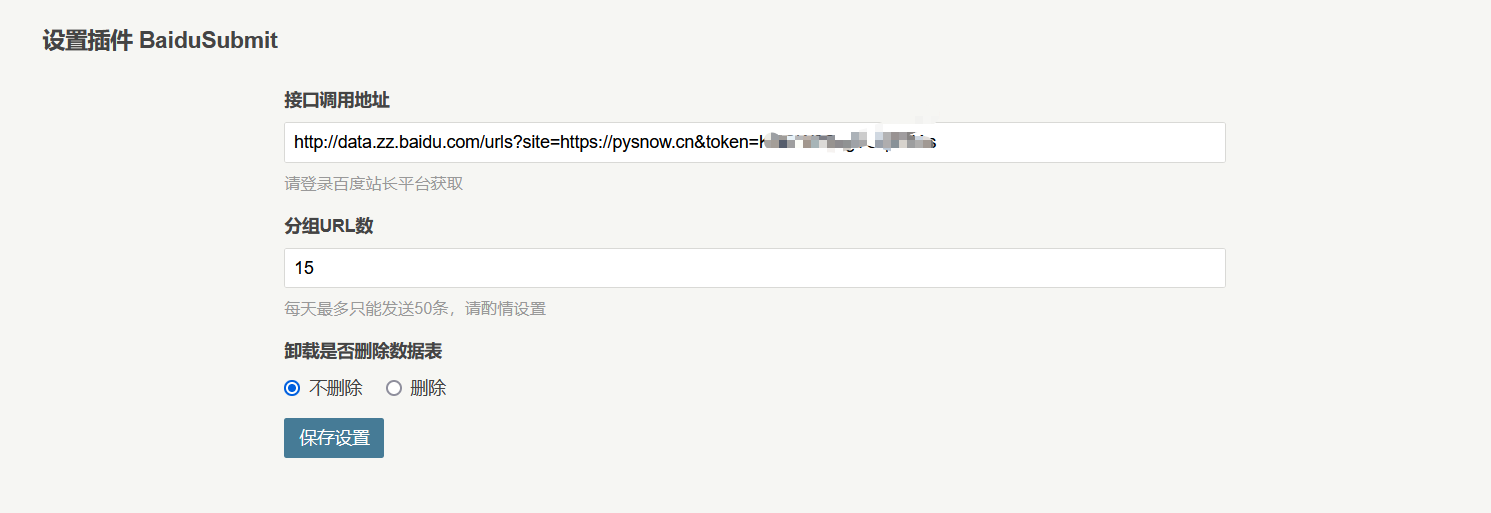

很简单,直接填一个api,发布的时候会自动提交类似这个api的更新文章

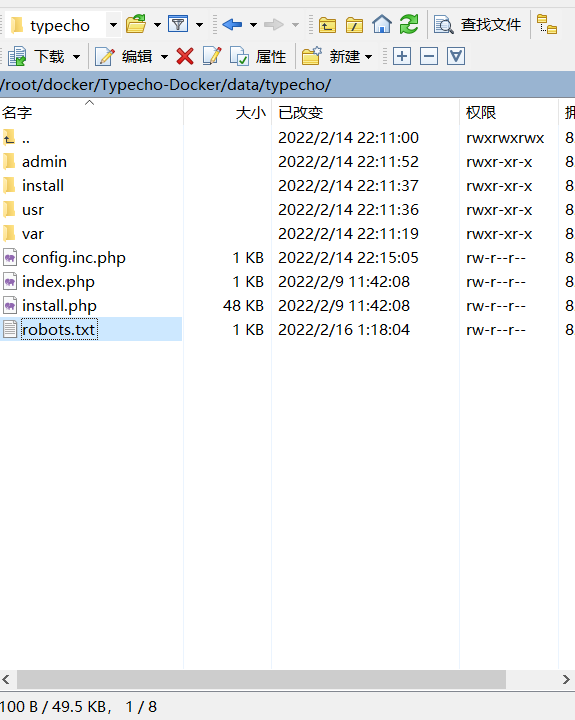

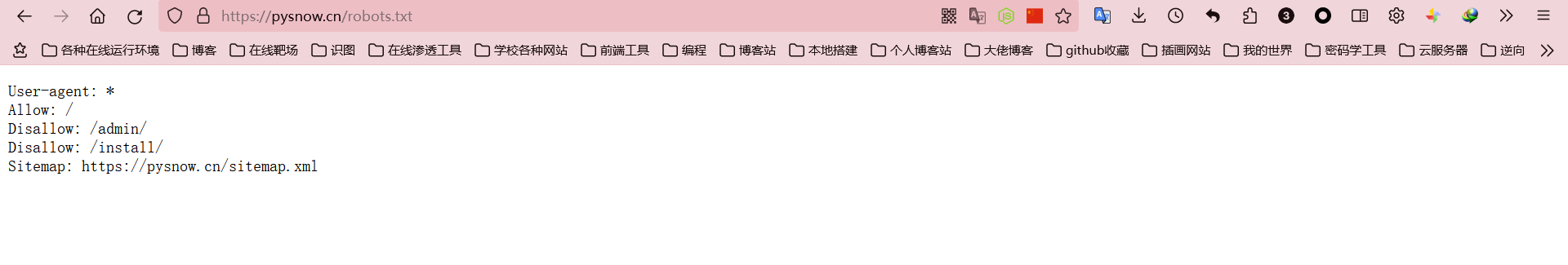

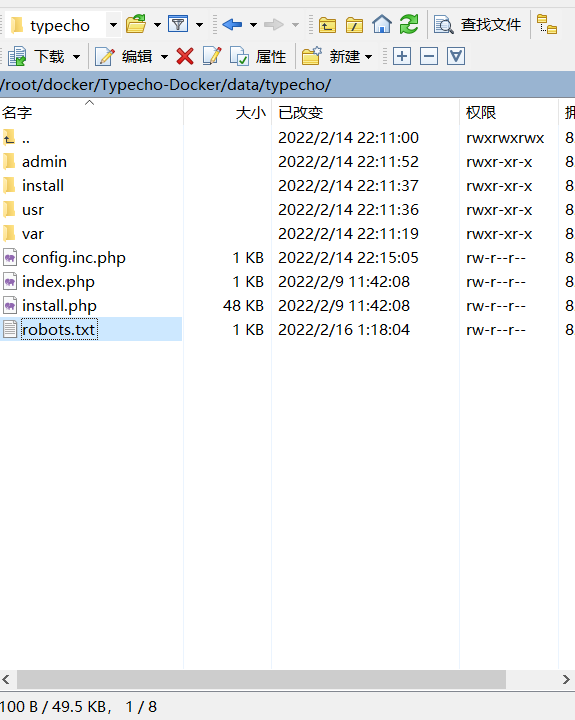

机器人文件

使用爬虫的人应该对此非常熟悉。简而言之,是爬虫的“君子协定”。虽然我们平时不遵守君子协定,但百度、搜狗、谷歌等大搜索引擎还是会遵守的。是的,这个约束只是对它们的约束。哈哈,由于这个插件没有自动生成robots.txt的功能,所以需要我们自己创建。方法也很简单。步骤如下

创建一个名为 robots.txt 的新文件

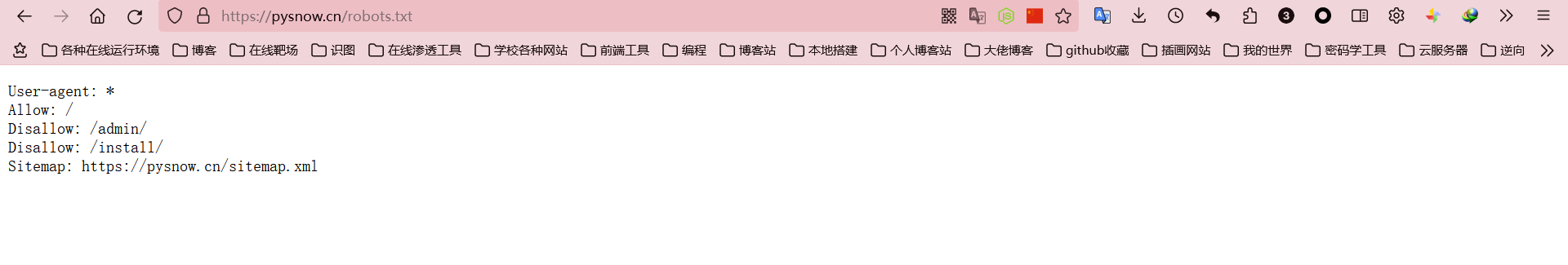

输入内容

User-agent: *

Allow: /

Disallow: /admin/

Disallow: /install/

Sitemap: https://你的网站地址/sitemap.xml

这个语法很简单,可以根据自己网站的需要进行修改

保存并上传文件到 网站 根目录

最后,访问自己 网站 进行验证

好的,你完成了

查看您的网站是否被 收录 阻止

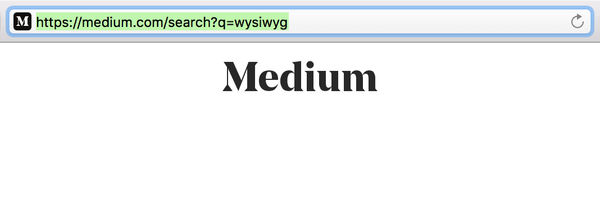

最常用的方法是在搜索引擎上搜索您的一篇文章文章。如果你找到了,说明你已经收录

这里推荐一个查看你整个站点的收录情况的方法(使用搜索语法site:xxx),具体示例如下

可以看到百度收录已经添加了我以前的站点,所以这里有一点你可以知道的是,百度收录并不是你提交资源后就可以立即更新的东西,他会是定期更新,可能是一周或一个月(废话)

总结

其实搜索引擎的收录只需要提交一个链接,搜索引擎就会自动抓取你的链接。这个插件自动生成sitemap.xml文件,可以很方便的让其他搜索引擎收录,所以一个sitemap插件就够了。下面我将给出各大搜索引擎站长的网站地址。你可以直接写你的网站地址,让他们自己爬。, 收录不会马上成功的。这主要取决于不同的搜索引擎,以及您网站的各种结果,其中涉及到 SEO 问题。我对此一无所知。问运维老板。. 最后,祝你折腾网站开心! 查看全部

文章采集api(一个博客小站来说的收录方式文章目录资源前言)

typechoSEO网站收录插件推荐百度提交

文章目录

资源前言

我们在建一个小站点的时候,可能会遇到如何让搜索引擎抓取我们的文章的问题,当然你可以选择不让搜索引擎抓取你的站点。这时候,你就需要SEO(“搜索引擎优化”)。其实涉及的内容很多,但作为我这种小博客网站,没必要。无非就是让你的网站在搜索引擎中的排名更高,让运维来做。在这篇文章中,我主要讲一下我在SEO方面采取的一些做法,主要是百度收录,其他搜索引擎的收录方法类似,大家可以自行搜索理解

安装

把下载好的插件解压到typecho主目录下的插件目录下,一般是/usr/plugins

然后就可以在typecho的后台插件中看到了

百度站长网站设置

百度搜索引擎提供了站长网站,这样我们就可以主动让百度去收录自己的站点,下面是传送门

门户网站

他提供了几种不同的收录方法,比如quick收录,可以让你主动提供你网站的一些资源,比如sitemap等,缩短搜索引擎爬虫爬取你的时间地点。具体方法有API提交、站点地图、手动提交。这次推荐的插件主要是API提交。

API 提交

推送接口、推送实例、推送反馈如上所示。我们只需要关注推送接口即可。后两者在实现代码时需要注意。显然,插件作者已经做到了这一点。以下是API接口的样式。

http://data.zz.baidu.com/urls?site={您的站点}&token={验证token,相当于密码}

网站地图

要提交站点地图,您可以使用 txt 或 xml 格式。这里可以直接使用这个插件生成的xml文件,大部分搜索引擎都识别sitemaps(我不知道),比如你可以看一下我的站点自动生成的xml。文档

如果您熟悉 XML,很容易发现大部分站点地图实际上是由这些多个 url 元素组成的。

所以我们可以填写对应的

不仅可以在这里使用站点的路径,而且在这里这样做更方便。另外,这个站点地图一天最多只能推送十次。

手动提交

也就是提交你网站上写的文章的链接,也就是把sitemap.xml内容中的url链接一个一个提交,这个方法可以保证你的一个文章可以很好收录(不一定,还是看百度吧),自己决定

百度站长其他工具

喜欢什么移动适配,死链接提交可以自己看懂,什么都写清楚了哈哈

插件介绍功能使用

很简单,直接填一个api,发布的时候会自动提交类似这个api的更新文章

机器人文件

使用爬虫的人应该对此非常熟悉。简而言之,是爬虫的“君子协定”。虽然我们平时不遵守君子协定,但百度、搜狗、谷歌等大搜索引擎还是会遵守的。是的,这个约束只是对它们的约束。哈哈,由于这个插件没有自动生成robots.txt的功能,所以需要我们自己创建。方法也很简单。步骤如下

创建一个名为 robots.txt 的新文件

输入内容

User-agent: *

Allow: /

Disallow: /admin/

Disallow: /install/

Sitemap: https://你的网站地址/sitemap.xml

这个语法很简单,可以根据自己网站的需要进行修改

保存并上传文件到 网站 根目录

最后,访问自己 网站 进行验证

好的,你完成了

查看您的网站是否被 收录 阻止

最常用的方法是在搜索引擎上搜索您的一篇文章文章。如果你找到了,说明你已经收录

这里推荐一个查看你整个站点的收录情况的方法(使用搜索语法site:xxx),具体示例如下

可以看到百度收录已经添加了我以前的站点,所以这里有一点你可以知道的是,百度收录并不是你提交资源后就可以立即更新的东西,他会是定期更新,可能是一周或一个月(废话)

总结

其实搜索引擎的收录只需要提交一个链接,搜索引擎就会自动抓取你的链接。这个插件自动生成sitemap.xml文件,可以很方便的让其他搜索引擎收录,所以一个sitemap插件就够了。下面我将给出各大搜索引擎站长的网站地址。你可以直接写你的网站地址,让他们自己爬。, 收录不会马上成功的。这主要取决于不同的搜索引擎,以及您网站的各种结果,其中涉及到 SEO 问题。我对此一无所知。问运维老板。. 最后,祝你折腾网站开心!

文章采集api(如何用R调用API,提取和整理你需要的免费Web数据)

采集交流 • 优采云 发表了文章 • 0 个评论 • 180 次浏览 • 2022-02-27 00:28

API是获取Web数据的重要方式之一。想了解如何使用 R 调用 API 来提取和组织您需要的免费 Web 数据吗?本文将逐步向您展示操作过程。

交易

俗话说,“聪明的女人,没有饭难煮”。就算你掌握了数据分析十八门武功,没有数据也是一件麻烦的事情。“拔刀而去,茫然不知所措”,大概就是这样。

有很多数据来源。Web 数据是数量庞大且相对容易获取的类型之一。更好的是,很多网络数据都是免费的。

在这个所谓的大数据时代,如何获取网络数据?

许多人使用由他人编译和发布的数据集。

他们很幸运,他们的工作可以建立在其他人的基础上。这是最有效的。

但并不是每个人都这么幸运。如果您需要的数据从未被组织和发布过怎么办?

事实上,这样的数据量更大。我们是否对他们视而不见?

如果您考虑爬行动物,那么您的想法是正确的。爬虫可以为您获取几乎所有可见(甚至不可见)的网络数据。然而,编写和使用爬虫的成本很高。包括时间资源、技术能力等。如果你遇到任何网络数据获取问题,你不要想“大锤”,有时可能是“刀枪不入”。

在“别人准备的数据”和“需要自己爬取的数据”之间,还有一个广阔的领域,这就是API的世界。

什么是 API?

它是应用程序编程接口的缩写。具体来说,某个网站的数据在不断的积累和变化。如果对这些数据进行整理,不仅费时,而且占用空间,而且还有刚整理完就过时的危险。大多数人需要的数据其实只是其中的一小部分,但时效性要求可能非常强。因此,组织存储并将其提供给公众以供下载是不经济的。

但是,如果数据不能以某种方式打通,就会面临无数爬虫的骚扰。这会对网站的正常运行造成很大的困扰。折衷方案是 网站 主动提供通道。当你需要某部分数据时,虽然没有现成的数据集,但你只需要用这个通道描述你想要的数据,然后网站审核后(一般是自动化的,瞬间完成),认为我可以给你,我会立即发送你明确要求的数据。双方都很高兴。

以后在找数据的时候,不妨看看目标网站有没有提供API,避免无用的努力。

在这个github项目中,有一个非常详细的列表,涵盖了当前常见的主流网站API资源状况。作者还在整理和修改中,大家可以采集起来慢慢看。

如果我们知道某个网站提供了API,通过查看文档知道我们需要的数据在那里,那么问题就变成了——如何通过API获取数据?

下面我们用一个实际的例子来向您展示整个操作步骤。

资源

我们正在寻找的例子是维基百科。

有关 Wikipedia API 的概述,请参阅此页面。

假设我们关心特定时间段内对指定维基百科 文章 页面的访问次数。

维基百科为我们提供了一种称为指标的数据,它涵盖了页面访问的关键价值。对应API的介绍页面在这里。

页面上有一个示例。假设需要获取2015年10月爱因斯坦入口页面的访问次数,可以这样调用:

GET http://wikimedia.org/api/rest_ ... %3Bbr style="box-sizing:border-box;margin:0px;padding:0px;" />

我们可以在浏览器的地址栏中输入GET后的一长串URL,然后回车看看我们得到了什么结果。

在浏览器中,我们看到了上图中的一长串文字。您可能想知道 - 这是什么?

恭喜,这是我们需要得到的数据。但是,它使用一种称为 JSON 的特殊数据格式。

JSON是互联网上数据交互的主流格式之一。如果你想了解 JSON 的含义和用法,可以参考这篇教程。

在浏览器中,我们最初只能看到数据的第一部分。但它已经收录了有价值的内容:

{"items":[{"project":"en.wikipedia","article":"Albert_Einstein","granularity":"daily","timestamp":"2015100100","access":"all-access","agent":"all-agents","views":18860}<br style="box-sizing:border-box;margin:0px;padding:0px;" />

在本段中,我们看到项目名称(en.wikipedia)、文章 标题(Albert Einstein)、统计粒度(天)、时间戳(10/1/2015)、访问类型(全部)、终端类型(全部) 和访问次数 (18860).

我们使用滑块将返回的文本拖到最后,我们会看到如下信息:

{"project":"en.wikipedia","article":"Albert_Einstein","granularity":"daily","timestamp":"2015103100","access":"all-access","agent":"all-agents","views":16380}]}<br style="box-sizing:border-box;margin:0px;padding:0px;" />

与 10 月 1 日的数据相比,只有时间戳(2015 年 10 月 31 日)和访问次数(16380))发生了变化。

在中间,我们跳过了 10 月 2 日至 10 月 30 日之间的数据。存储格式相同,只是日期和访问次数的数据值在变化。

您需要的所有数据都在这里,您只需提取相应的信息即可。但是如果手动进行(比如将需要的项目复制粘贴到Excel中),显然效率低下,容易出错。让我们展示如何使用 R 编程环境自动化这个过程。

准备

在正式用 R 调用 API 之前,我们需要做一些必要的准备工作。

首先是安装R。

请到本网站下载R基础安装包。

R的下载位置比较多,建议选择清华镜像,下载速度比较快。

请根据您的操作系统平台选择对应的版本进行下载。我正在使用 macOS 版本。

下载 pkg 文件。双击安装。

安装完基础包后,我们继续安装集成开发环境RStudio。它可以帮助您轻松和交互式地与 R 进行交流。RStudio的下载地址在这里。

根据你的操作系统,选择对应的安装包。macOS 安装包是一个 dmg 文件。双击打开后,将RStudio.app图标拖到Applications文件夹下,安装完成。

下面我们双击从应用程序目录运行RStudio。

我们先在 RStudio 的 Console 中运行以下语句来安装一些需要的包:

install.packages("tidyverse")<br style="box-sizing:border-box;margin:0px;padding:0px;" />install.packages("rlist")<br style="box-sizing:border-box;margin:0px;padding:0px;" />

安装完成后,在菜单中选择File->New,在如下界面中选择R Notebook。

R Notebook 默认为我们提供了一个带有一些基本使用说明的模板。

让我们尝试在编辑区域(左)的代码部分(灰色)中单击运行按钮。

情节的结果可以立即看到。

我们点击菜单栏上的Preview按钮来查看整个代码的效果。操作的结果将以带有图片和文本的 HTML 文件的形式显示。

现在我们已经熟悉了环境,是时候实际运行我们的代码了。我们把编辑区的开头描述区保留在左边,删除其余的,把文件名改成有意义的web-data-api-with-R。

至此,准备工作就绪。现在我们要开始实际操作了。

操作

在实际操作过程中,我们以维基百科的另一个wiki文章为例来证明这种操作方法的通用性。选中的文章就是我们介绍词云制作时使用的那个,叫做“Yes, Minisiter”。这是一部 1980 年代的英国喜剧。

我们先在浏览器中试一下,看看能否修改 API 示例中的参数,获取“是,部长”文章 的访问统计信息。作为测试,我们仅采集 2017 年 10 月 1 日至 2017 年 10 月 3 日 3 天的数据。

与示例相反,我们需要替换的内容包括开始和结束时间以及 文章 标题。

我们在浏览器的地址栏中输入:

https://wikimedia.org/api/rest ... %3Bbr style="box-sizing:border-box;margin:0px;padding:0px;" />

返回结果如下:

数据可以正常返回。接下来,我们使用语句方法在 RStudio 中调用。

请注意,在下面的代码中,程序的输出部分会在开头带有## 标记,以区别于执行代码本身。

启动后,我们需要设置时区。否则,您稍后在处理时间数据时会遇到错误。

Sys.setenv(TZ="Asia/Shanghai")<br style="box-sizing:border-box;margin:0px;padding:0px;" />

然后,我们调用 tidyverse 包,它是一个可以同时加载许多函数的集合,我们稍后会用到。

library(tidyverse)<br style="box-sizing:border-box;margin:0px;padding:0px;" /><br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: ggplot2<br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: tibble<br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: tidyr<br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: readr<br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: purrr<br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: dplyr<br style="box-sizing:border-box;margin:0px;padding:0px;" /><br style="box-sizing:border-box;margin:0px;padding:0px;" />## Conflicts with tidy packages ----------------------------------------------<br style="box-sizing:border-box;margin:0px;padding:0px;" /><br style="box-sizing:border-box;margin:0px;padding:0px;" />## filter(): dplyr, stats<br style="box-sizing:border-box;margin:0px;padding:0px;" />## lag(): dplyr, stats<br style="box-sizing:border-box;margin:0px;padding:0px;" />

这里可能有一些警告,请忽略它们。它对我们的运营没有影响。

根据前面的例子,我们定义要查询的时间跨度,并指定要查找的wiki文章的名称。

请注意,与 Python 不同,在 R 中,赋值采用标记,而不是 =。不过,R 语言其实很容易上手。如果你坚持使用=,它也能识别,不会报错。

<p>starting 查看全部

文章采集api(如何用R调用API,提取和整理你需要的免费Web数据)

API是获取Web数据的重要方式之一。想了解如何使用 R 调用 API 来提取和组织您需要的免费 Web 数据吗?本文将逐步向您展示操作过程。

交易

俗话说,“聪明的女人,没有饭难煮”。就算你掌握了数据分析十八门武功,没有数据也是一件麻烦的事情。“拔刀而去,茫然不知所措”,大概就是这样。

有很多数据来源。Web 数据是数量庞大且相对容易获取的类型之一。更好的是,很多网络数据都是免费的。

在这个所谓的大数据时代,如何获取网络数据?

许多人使用由他人编译和发布的数据集。

他们很幸运,他们的工作可以建立在其他人的基础上。这是最有效的。

但并不是每个人都这么幸运。如果您需要的数据从未被组织和发布过怎么办?

事实上,这样的数据量更大。我们是否对他们视而不见?

如果您考虑爬行动物,那么您的想法是正确的。爬虫可以为您获取几乎所有可见(甚至不可见)的网络数据。然而,编写和使用爬虫的成本很高。包括时间资源、技术能力等。如果你遇到任何网络数据获取问题,你不要想“大锤”,有时可能是“刀枪不入”。

在“别人准备的数据”和“需要自己爬取的数据”之间,还有一个广阔的领域,这就是API的世界。

什么是 API?

它是应用程序编程接口的缩写。具体来说,某个网站的数据在不断的积累和变化。如果对这些数据进行整理,不仅费时,而且占用空间,而且还有刚整理完就过时的危险。大多数人需要的数据其实只是其中的一小部分,但时效性要求可能非常强。因此,组织存储并将其提供给公众以供下载是不经济的。

但是,如果数据不能以某种方式打通,就会面临无数爬虫的骚扰。这会对网站的正常运行造成很大的困扰。折衷方案是 网站 主动提供通道。当你需要某部分数据时,虽然没有现成的数据集,但你只需要用这个通道描述你想要的数据,然后网站审核后(一般是自动化的,瞬间完成),认为我可以给你,我会立即发送你明确要求的数据。双方都很高兴。

以后在找数据的时候,不妨看看目标网站有没有提供API,避免无用的努力。

在这个github项目中,有一个非常详细的列表,涵盖了当前常见的主流网站API资源状况。作者还在整理和修改中,大家可以采集起来慢慢看。

如果我们知道某个网站提供了API,通过查看文档知道我们需要的数据在那里,那么问题就变成了——如何通过API获取数据?

下面我们用一个实际的例子来向您展示整个操作步骤。

资源

我们正在寻找的例子是维基百科。

有关 Wikipedia API 的概述,请参阅此页面。

假设我们关心特定时间段内对指定维基百科 文章 页面的访问次数。

维基百科为我们提供了一种称为指标的数据,它涵盖了页面访问的关键价值。对应API的介绍页面在这里。

页面上有一个示例。假设需要获取2015年10月爱因斯坦入口页面的访问次数,可以这样调用:

GET http://wikimedia.org/api/rest_ ... %3Bbr style="box-sizing:border-box;margin:0px;padding:0px;" />

我们可以在浏览器的地址栏中输入GET后的一长串URL,然后回车看看我们得到了什么结果。

在浏览器中,我们看到了上图中的一长串文字。您可能想知道 - 这是什么?

恭喜,这是我们需要得到的数据。但是,它使用一种称为 JSON 的特殊数据格式。

JSON是互联网上数据交互的主流格式之一。如果你想了解 JSON 的含义和用法,可以参考这篇教程。

在浏览器中,我们最初只能看到数据的第一部分。但它已经收录了有价值的内容:

{"items":[{"project":"en.wikipedia","article":"Albert_Einstein","granularity":"daily","timestamp":"2015100100","access":"all-access","agent":"all-agents","views":18860}<br style="box-sizing:border-box;margin:0px;padding:0px;" />

在本段中,我们看到项目名称(en.wikipedia)、文章 标题(Albert Einstein)、统计粒度(天)、时间戳(10/1/2015)、访问类型(全部)、终端类型(全部) 和访问次数 (18860).

我们使用滑块将返回的文本拖到最后,我们会看到如下信息:

{"project":"en.wikipedia","article":"Albert_Einstein","granularity":"daily","timestamp":"2015103100","access":"all-access","agent":"all-agents","views":16380}]}<br style="box-sizing:border-box;margin:0px;padding:0px;" />

与 10 月 1 日的数据相比,只有时间戳(2015 年 10 月 31 日)和访问次数(16380))发生了变化。

在中间,我们跳过了 10 月 2 日至 10 月 30 日之间的数据。存储格式相同,只是日期和访问次数的数据值在变化。

您需要的所有数据都在这里,您只需提取相应的信息即可。但是如果手动进行(比如将需要的项目复制粘贴到Excel中),显然效率低下,容易出错。让我们展示如何使用 R 编程环境自动化这个过程。

准备

在正式用 R 调用 API 之前,我们需要做一些必要的准备工作。

首先是安装R。

请到本网站下载R基础安装包。

R的下载位置比较多,建议选择清华镜像,下载速度比较快。

请根据您的操作系统平台选择对应的版本进行下载。我正在使用 macOS 版本。

下载 pkg 文件。双击安装。

安装完基础包后,我们继续安装集成开发环境RStudio。它可以帮助您轻松和交互式地与 R 进行交流。RStudio的下载地址在这里。

根据你的操作系统,选择对应的安装包。macOS 安装包是一个 dmg 文件。双击打开后,将RStudio.app图标拖到Applications文件夹下,安装完成。

下面我们双击从应用程序目录运行RStudio。

我们先在 RStudio 的 Console 中运行以下语句来安装一些需要的包:

install.packages("tidyverse")<br style="box-sizing:border-box;margin:0px;padding:0px;" />install.packages("rlist")<br style="box-sizing:border-box;margin:0px;padding:0px;" />

安装完成后,在菜单中选择File->New,在如下界面中选择R Notebook。

R Notebook 默认为我们提供了一个带有一些基本使用说明的模板。

让我们尝试在编辑区域(左)的代码部分(灰色)中单击运行按钮。

情节的结果可以立即看到。

我们点击菜单栏上的Preview按钮来查看整个代码的效果。操作的结果将以带有图片和文本的 HTML 文件的形式显示。

现在我们已经熟悉了环境,是时候实际运行我们的代码了。我们把编辑区的开头描述区保留在左边,删除其余的,把文件名改成有意义的web-data-api-with-R。

至此,准备工作就绪。现在我们要开始实际操作了。

操作

在实际操作过程中,我们以维基百科的另一个wiki文章为例来证明这种操作方法的通用性。选中的文章就是我们介绍词云制作时使用的那个,叫做“Yes, Minisiter”。这是一部 1980 年代的英国喜剧。

我们先在浏览器中试一下,看看能否修改 API 示例中的参数,获取“是,部长”文章 的访问统计信息。作为测试,我们仅采集 2017 年 10 月 1 日至 2017 年 10 月 3 日 3 天的数据。

与示例相反,我们需要替换的内容包括开始和结束时间以及 文章 标题。

我们在浏览器的地址栏中输入:

https://wikimedia.org/api/rest ... %3Bbr style="box-sizing:border-box;margin:0px;padding:0px;" />

返回结果如下:

数据可以正常返回。接下来,我们使用语句方法在 RStudio 中调用。

请注意,在下面的代码中,程序的输出部分会在开头带有## 标记,以区别于执行代码本身。

启动后,我们需要设置时区。否则,您稍后在处理时间数据时会遇到错误。

Sys.setenv(TZ="Asia/Shanghai")<br style="box-sizing:border-box;margin:0px;padding:0px;" />

然后,我们调用 tidyverse 包,它是一个可以同时加载许多函数的集合,我们稍后会用到。

library(tidyverse)<br style="box-sizing:border-box;margin:0px;padding:0px;" /><br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: ggplot2<br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: tibble<br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: tidyr<br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: readr<br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: purrr<br style="box-sizing:border-box;margin:0px;padding:0px;" />## Loading tidyverse: dplyr<br style="box-sizing:border-box;margin:0px;padding:0px;" /><br style="box-sizing:border-box;margin:0px;padding:0px;" />## Conflicts with tidy packages ----------------------------------------------<br style="box-sizing:border-box;margin:0px;padding:0px;" /><br style="box-sizing:border-box;margin:0px;padding:0px;" />## filter(): dplyr, stats<br style="box-sizing:border-box;margin:0px;padding:0px;" />## lag(): dplyr, stats<br style="box-sizing:border-box;margin:0px;padding:0px;" />

这里可能有一些警告,请忽略它们。它对我们的运营没有影响。

根据前面的例子,我们定义要查询的时间跨度,并指定要查找的wiki文章的名称。

请注意,与 Python 不同,在 R 中,赋值采用标记,而不是 =。不过,R 语言其实很容易上手。如果你坚持使用=,它也能识别,不会报错。

<p>starting

文章采集api(在之前的文章中Python实现“维基百科六度分隔理论”)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-02-24 21:13

在之前的文章 Python实现“维基百科六度分离理论”基础爬虫中,我们实现了一个网站随机从一个链接到另一个链接,但是如果我们需要系统对整个< @网站 分类,或者要搜索 网站 上的每一页,我们该怎么办?我们需要采集整个网站,但这是一个非常占用内存的过程,尤其是在处理大的网站时,更合适的工具是使用数据库来存储< @k11 资源为@>,之前也说过。这是如何做到的。网站地图站点地图网站地图,也称为站点地图,是一个页面,上面放置了网站上所有需要被搜索引擎抓取的页面(注:不是所有页面,所有 文章 链接。大多数人在 网站 上找不到所需信息时,可能会求助于 网站 地图。搜索引擎蜘蛛我非常喜欢 网站maps。对于 SEO,网站maps 的好处: 1. 为搜索引擎蜘蛛提供可以浏览整个 网站 的链接,简单地反映 网站 的整体框架 2. 为搜索引擎提供一些链接蜘蛛指向动态页面或其他方法更难访问的页面;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。当他们在 网站 上找不到他们需要的信息时,地图作为一种补救措施。搜索引擎蜘蛛我非常喜欢 网站maps。对于 SEO,网站maps 的好处: 1. 为搜索引擎蜘蛛提供可以浏览整个 网站 的链接,简单地反映 网站 的整体框架 2. 为搜索引擎提供一些链接蜘蛛指向动态页面或其他方法更难访问的页面;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。当他们在 网站 上找不到他们需要的信息时,地图作为一种补救措施。搜索引擎蜘蛛我非常喜欢 网站maps。对于 SEO,网站maps 的好处: 1. 为搜索引擎蜘蛛提供可以浏览整个 网站 的链接,简单地反映 网站 的整体框架 2. 为搜索引擎提供一些链接蜘蛛指向动态页面或其他方法更难访问的页面;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。@网站。搜索引擎蜘蛛我非常喜欢 网站maps。对于 SEO,网站maps 的好处: 1. 为搜索引擎蜘蛛提供可以浏览整个 网站 的链接,简单地反映 网站 的整体框架 2. 为搜索引擎提供一些链接蜘蛛指向动态页面或其他方法更难访问的页面;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。@网站。搜索引擎蜘蛛我非常喜欢 网站maps。对于 SEO,网站maps 的好处: 1. 为搜索引擎蜘蛛提供可以浏览整个 网站 的链接,简单地反映 网站 的整体框架 2. 为搜索引擎提供一些链接蜘蛛指向动态页面或其他方法更难访问的页面;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。为搜索引擎蜘蛛提供可以浏览整个网站的链接,简单反映网站的整体框架 2. 为搜索引擎蜘蛛提供一些链接,指向动态页面或更难到达的页面其他方法;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。为搜索引擎蜘蛛提供可以浏览整个网站的链接,简单反映网站的整体框架 2. 为搜索引擎蜘蛛提供一些链接,指向动态页面或更难到达的页面其他方法;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。作为一个潜在的着陆页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。作为一个潜在的着陆页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。

数据采集采集网站数据不难,但需要爬虫有足够的深度。我们创建了一个爬虫,它递归地遍历每个 网站 并且只采集那些 网站 页面上的数据。通常耗时的 网站采集 方法从顶层页面(通常是 网站 主页)开始,然后搜索页面上的所有链接,形成一个列表,然后去到采集到这些链接的页面,继续采集到每个页面的链接形成一个新列表,重复执行。显然,这是一个复杂性迅速增长的过程。每页添加 10 个链接,在 网站 上添加 5 个页面深度。如果采集 整个网站,则采集 页的总数为105,即100,000 页。因为很多网站的内部链接都是重复的,为了避免重复的采集,需要链接和去重。在 Python 中,最常用的去重方法是使用内置的集合采集方法。只有“新”链接是 采集。看一下代码示例: from urllib.request import urlopenfrom bs4 import BeautifulSoup import repages = set()def getLinks(pageurl):globalpageshtml= urlopen("" + pageurl)soup= BeautifulSoup(html)forlink in soup.findAll( "a", href=pile("^(/wiki/)")):if'href' in link.attrs:iflink.attrs['href'] not in pages:#这是一个新页面 newPage= 链接。属性[' @采集。看一下代码示例: from urllib.request import urlopenfrom bs4 import BeautifulSoup import repages = set()def getLinks(pageurl):globalpageshtml= urlopen("" + pageurl)soup= BeautifulSoup(html)forlink in soup.findAll( "a", href=pile("^(/wiki/)")):if'href' in link.attrs:iflink.attrs['href'] not in pages:#这是一个新页面 newPage= 链接。属性[' @采集。看一下代码示例: from urllib.request import urlopenfrom bs4 import BeautifulSoup import repages = set()def getLinks(pageurl):globalpageshtml= urlopen("" + pageurl)soup= BeautifulSoup(html)forlink in soup.findAll( "a", href=pile("^(/wiki/)")):if'href' in link.attrs:iflink.attrs['href'] not in pages:#这是一个新页面 newPage= 链接。属性['

递归警告:Python 的默认递归*为 1000 次,因为维基百科的链接太多,所以程序在达到递归*时停止。如果你不想让它停止,你可以设置一个递归计数器或其他东西。采集整个网站数据为了有效地使用爬虫,我们在使用爬虫时需要在页面上做一些事情。让我们创建一个爬虫来采集有关页面标题、正文第一段和编辑页面的链接(如果有的话)的信息。第一步,我们需要在网站上观察页面,然后制定采集模式,通过F12(一般情况下)检查元素,就可以看到页面的构成了。查看维基百科页面,包括入口和非入口页面,例如隐私政策页面,可以得出以下规则:所有标题都在h1→span标签中,页面上只有一个h1标签。所有正文都在 div#bodyContent 标记中。如果要获取第一段文字,可以使用div#mw-content-text→p。此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 并且页面上只有一个 h1 标签。所有正文都在 div#bodyContent 标记中。如果要获取第一段文字,可以使用div#mw-content-text→p。此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 并且页面上只有一个 h1 标签。所有正文都在 div#bodyContent 标记中。如果要获取第一段文字,可以使用div#mw-content-text→p。此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 所有正文都在 div#bodyContent 标记中。如果要获取第一段文字,可以使用div#mw-content-text→p。此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 所有正文都在 div#bodyContent 标记中。如果要获取第一段文字,可以使用div#mw-content-text→p。此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href'

<p>在数据存储到 MySQL 之前,数据已经被获取。直接打印出来比较麻烦,所以我们可以直接存入MySQL。这里只存储链接是没有意义的,所以我们存储页面的标题和内容。我之前有两篇文章 文章 介绍了如何在 MySQL 中存储数据。数据表为pages,代码如下: import reimport datetimeimport randomimport pymysqlconn = pymysql.connect(host = '127.< @0. 查看全部

文章采集api(在之前的文章中Python实现“维基百科六度分隔理论”)

在之前的文章 Python实现“维基百科六度分离理论”基础爬虫中,我们实现了一个网站随机从一个链接到另一个链接,但是如果我们需要系统对整个< @网站 分类,或者要搜索 网站 上的每一页,我们该怎么办?我们需要采集整个网站,但这是一个非常占用内存的过程,尤其是在处理大的网站时,更合适的工具是使用数据库来存储< @k11 资源为@>,之前也说过。这是如何做到的。网站地图站点地图网站地图,也称为站点地图,是一个页面,上面放置了网站上所有需要被搜索引擎抓取的页面(注:不是所有页面,所有 文章 链接。大多数人在 网站 上找不到所需信息时,可能会求助于 网站 地图。搜索引擎蜘蛛我非常喜欢 网站maps。对于 SEO,网站maps 的好处: 1. 为搜索引擎蜘蛛提供可以浏览整个 网站 的链接,简单地反映 网站 的整体框架 2. 为搜索引擎提供一些链接蜘蛛指向动态页面或其他方法更难访问的页面;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。当他们在 网站 上找不到他们需要的信息时,地图作为一种补救措施。搜索引擎蜘蛛我非常喜欢 网站maps。对于 SEO,网站maps 的好处: 1. 为搜索引擎蜘蛛提供可以浏览整个 网站 的链接,简单地反映 网站 的整体框架 2. 为搜索引擎提供一些链接蜘蛛指向动态页面或其他方法更难访问的页面;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。当他们在 网站 上找不到他们需要的信息时,地图作为一种补救措施。搜索引擎蜘蛛我非常喜欢 网站maps。对于 SEO,网站maps 的好处: 1. 为搜索引擎蜘蛛提供可以浏览整个 网站 的链接,简单地反映 网站 的整体框架 2. 为搜索引擎提供一些链接蜘蛛指向动态页面或其他方法更难访问的页面;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。@网站。搜索引擎蜘蛛我非常喜欢 网站maps。对于 SEO,网站maps 的好处: 1. 为搜索引擎蜘蛛提供可以浏览整个 网站 的链接,简单地反映 网站 的整体框架 2. 为搜索引擎提供一些链接蜘蛛指向动态页面或其他方法更难访问的页面;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。@网站。搜索引擎蜘蛛我非常喜欢 网站maps。对于 SEO,网站maps 的好处: 1. 为搜索引擎蜘蛛提供可以浏览整个 网站 的链接,简单地反映 网站 的整体框架 2. 为搜索引擎提供一些链接蜘蛛指向动态页面或其他方法更难访问的页面;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。为搜索引擎蜘蛛提供可以浏览整个网站的链接,简单反映网站的整体框架 2. 为搜索引擎蜘蛛提供一些链接,指向动态页面或更难到达的页面其他方法;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。为搜索引擎蜘蛛提供可以浏览整个网站的链接,简单反映网站的整体框架 2. 为搜索引擎蜘蛛提供一些链接,指向动态页面或更难到达的页面其他方法;3、作为潜在的落地页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。作为一个潜在的着陆页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。作为一个潜在的着陆页,可以针对搜索流量进行优化;4. 如果您访问如果访问者试图访问一个在 网站 域中不存在的 URL,访问者将被重定向到“找不到文件”错误页面,并且 网站 映射可以用作该页面的“准”内容。

数据采集采集网站数据不难,但需要爬虫有足够的深度。我们创建了一个爬虫,它递归地遍历每个 网站 并且只采集那些 网站 页面上的数据。通常耗时的 网站采集 方法从顶层页面(通常是 网站 主页)开始,然后搜索页面上的所有链接,形成一个列表,然后去到采集到这些链接的页面,继续采集到每个页面的链接形成一个新列表,重复执行。显然,这是一个复杂性迅速增长的过程。每页添加 10 个链接,在 网站 上添加 5 个页面深度。如果采集 整个网站,则采集 页的总数为105,即100,000 页。因为很多网站的内部链接都是重复的,为了避免重复的采集,需要链接和去重。在 Python 中,最常用的去重方法是使用内置的集合采集方法。只有“新”链接是 采集。看一下代码示例: from urllib.request import urlopenfrom bs4 import BeautifulSoup import repages = set()def getLinks(pageurl):globalpageshtml= urlopen("" + pageurl)soup= BeautifulSoup(html)forlink in soup.findAll( "a", href=pile("^(/wiki/)")):if'href' in link.attrs:iflink.attrs['href'] not in pages:#这是一个新页面 newPage= 链接。属性[' @采集。看一下代码示例: from urllib.request import urlopenfrom bs4 import BeautifulSoup import repages = set()def getLinks(pageurl):globalpageshtml= urlopen("" + pageurl)soup= BeautifulSoup(html)forlink in soup.findAll( "a", href=pile("^(/wiki/)")):if'href' in link.attrs:iflink.attrs['href'] not in pages:#这是一个新页面 newPage= 链接。属性[' @采集。看一下代码示例: from urllib.request import urlopenfrom bs4 import BeautifulSoup import repages = set()def getLinks(pageurl):globalpageshtml= urlopen("" + pageurl)soup= BeautifulSoup(html)forlink in soup.findAll( "a", href=pile("^(/wiki/)")):if'href' in link.attrs:iflink.attrs['href'] not in pages:#这是一个新页面 newPage= 链接。属性['

递归警告:Python 的默认递归*为 1000 次,因为维基百科的链接太多,所以程序在达到递归*时停止。如果你不想让它停止,你可以设置一个递归计数器或其他东西。采集整个网站数据为了有效地使用爬虫,我们在使用爬虫时需要在页面上做一些事情。让我们创建一个爬虫来采集有关页面标题、正文第一段和编辑页面的链接(如果有的话)的信息。第一步,我们需要在网站上观察页面,然后制定采集模式,通过F12(一般情况下)检查元素,就可以看到页面的构成了。查看维基百科页面,包括入口和非入口页面,例如隐私政策页面,可以得出以下规则:所有标题都在h1→span标签中,页面上只有一个h1标签。所有正文都在 div#bodyContent 标记中。如果要获取第一段文字,可以使用div#mw-content-text→p。此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 并且页面上只有一个 h1 标签。所有正文都在 div#bodyContent 标记中。如果要获取第一段文字,可以使用div#mw-content-text→p。此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 并且页面上只有一个 h1 标签。所有正文都在 div#bodyContent 标记中。如果要获取第一段文字,可以使用div#mw-content-text→p。此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 所有正文都在 div#bodyContent 标记中。如果要获取第一段文字,可以使用div#mw-content-text→p。此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 所有正文都在 div#bodyContent 标记中。如果要获取第一段文字,可以使用div#mw-content-text→p。此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href' 此规则适用于除文件页面之外的所有页面。编辑链接仅出现在入口页面上。如果有编辑链接,则位于li#ca-edit标签的li#ca-edit→span→a中。调整前面的代码,我们可以构建一个爬虫和数据的组合程序采集,代码如下: import redef getLinks(pageUrl):global pageshtml = urlopen("" + pageUrl)soup = BeautifulSoup(html)尝试: print(soup.h1.get_text())print(soup.find(id="mw-content-text").findAll("p")[0])print(soup.find(id =" ca-edit").find("span").find("a").attrs['href'

<p>在数据存储到 MySQL 之前,数据已经被获取。直接打印出来比较麻烦,所以我们可以直接存入MySQL。这里只存储链接是没有意义的,所以我们存储页面的标题和内容。我之前有两篇文章 文章 介绍了如何在 MySQL 中存储数据。数据表为pages,代码如下: import reimport datetimeimport randomimport pymysqlconn = pymysql.connect(host = '127.< @0.

文章采集api(大数据搜集体系有哪些分类?搜集日志数据分类)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-02-24 21:11

【摘要】大数据采集技术对数据进行ETL运算,提取、转换、加载数据,最终挖掘数据的潜在价值,进而为用户提供解决方案或决策参考。那么,大数据采集系统的分类有哪些呢?今天就和小编一起来了解一下吧!

1、系统日志采集系统

采集和采集日志数据信息,然后进行数据分析,挖掘日志数据在公司交易渠道中的潜在价值。总之,采集日志数据提供了离线和在线的实时分析应用。目前常用的开源日志采集系统是 Flume。

2、网络数据采集系统

通过网络爬虫和一些网站渠道提供的公共API(如推特和新浪微博API)从网站获取数据。它可以从网页中提取非结构化数据和半结构化数据的网页数据,提取、清洗并转换为结构化数据,并存储为一致的本地文件数据。

目前常用的网络爬虫系统包括Apache Nutch、Crawler4j、Scrapy等结构。

3、数据库采集系统

数据库采集系统直接与企业事务后台服务器结合后,在企业事务后台每时每刻都将大量事务记录写入数据库,最终由特定的处理系统对系统进行分析。

目前,存储数据常用MySQL、Oracle等关系型数据库,采集数据也常用Redis、MongoDB等NoSQL数据库。

关于大数据采集系统的分类,青腾小编就在这里跟大家分享一下。如果你对大数据工程有浓厚的兴趣,希望这篇文章可以帮助到你。如果想了解更多数据分析师和大数据工程师的技能和资料,可以点击本站其他文章进行学习。 查看全部

文章采集api(大数据搜集体系有哪些分类?搜集日志数据分类)

【摘要】大数据采集技术对数据进行ETL运算,提取、转换、加载数据,最终挖掘数据的潜在价值,进而为用户提供解决方案或决策参考。那么,大数据采集系统的分类有哪些呢?今天就和小编一起来了解一下吧!

1、系统日志采集系统

采集和采集日志数据信息,然后进行数据分析,挖掘日志数据在公司交易渠道中的潜在价值。总之,采集日志数据提供了离线和在线的实时分析应用。目前常用的开源日志采集系统是 Flume。

2、网络数据采集系统

通过网络爬虫和一些网站渠道提供的公共API(如推特和新浪微博API)从网站获取数据。它可以从网页中提取非结构化数据和半结构化数据的网页数据,提取、清洗并转换为结构化数据,并存储为一致的本地文件数据。

目前常用的网络爬虫系统包括Apache Nutch、Crawler4j、Scrapy等结构。

3、数据库采集系统

数据库采集系统直接与企业事务后台服务器结合后,在企业事务后台每时每刻都将大量事务记录写入数据库,最终由特定的处理系统对系统进行分析。

目前,存储数据常用MySQL、Oracle等关系型数据库,采集数据也常用Redis、MongoDB等NoSQL数据库。

关于大数据采集系统的分类,青腾小编就在这里跟大家分享一下。如果你对大数据工程有浓厚的兴趣,希望这篇文章可以帮助到你。如果想了解更多数据分析师和大数据工程师的技能和资料,可以点击本站其他文章进行学习。

文章采集api(Scrapy一个 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2022-02-23 07:17

)

内容

架构介绍

Scrapy 是一个开源和协作框架,最初是为页面抓取(更准确地说是网页抓取)而设计的,它允许您以快速、简单和可扩展的方式从所需数据中提取所有信息。但目前,Scrapy 的用途非常广泛,例如数据挖掘、监控和自动化测试,也可以用来获取 API(例如 Amazon Associates Web Services)或一般网络爬虫返回的数据。

Scrapy 是基于 twisted 框架开发的,这是一个流行的事件驱动的 Python 网络框架。所以 Scrapy 使用非阻塞(又名异步)代码来实现并发。整体结构大致如下

IO多路复用

# 引擎(EGINE)(大总管)

引擎负责控制系统所有组件之间的数据流,并在某些动作发生时触发事件。有关详细信息,请参见上面的数据流部分。

# 调度器(SCHEDULER)

用来接受引擎发过来的请求, 压入队列中, 并在引擎再次请求的时候返回. 可以想像成一个URL的优先级队列, 由它来决定下一个要抓取的网址是什么, 同时去除重复的网址

# 下载器(DOWLOADER)

用于下载网页内容, 并将网页内容返回给EGINE,下载器是建立在twisted这个高效的异步模型上的

# 爬虫(SPIDERS)

SPIDERS是开发人员自定义的类,用来解析responses,并且提取items,或者发送新的请求

# 项目管道(ITEM PIPLINES)

在items被提取后负责处理它们,主要包括清理、验证、持久化(比如存到数据库)等操作

# 两个中间件

-爬虫中间件

-下载中间件(用的最多,加头,加代理,加cookie,集成selenium)

安装创建和启动

# 1 框架 不是 模块

# 2 号称爬虫界的django(你会发现,跟django很多地方一样)

# 3 安装

-mac,linux平台:pip3 install scrapy

-windows平台:pip3 install scrapy(大部分人可以)

- 如果失败:

1、pip3 install wheel #安装后,便支持通过wheel文件安装软件,wheel文件官网:https://www.lfd.uci.edu/~gohlke/pythonlibs

3、pip3 install lxml

4、pip3 install pyopenssl

5、下载并安装pywin32:https://sourceforge.net/projec ... in32/

6、下载twisted的wheel文件:http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted

7、执行pip3 install 下载目录\Twisted-17.9.0-cp36-cp36m-win_amd64.whl

8、pip3 install scrapy

# 4 在script文件夹下会有scrapy.exe可执行文件

-创建scrapy项目:scrapy startproject 项目名 (django创建项目)

-创建爬虫:scrapy genspider 爬虫名 要爬取的网站地址 # 可以创建多个爬虫

# 5 命令启动爬虫

-scrapy crawl 爬虫名字

-scrapy crawl 爬虫名字 --nolog # 没有日志输出启动

# 6 文件执行爬虫(推荐使用)

-在项目路径下创建一个main.py,右键执行即可

from scrapy.cmdline import execute

# execute(['scrapy','crawl','chouti','--nolog']) # 没有设置日志级别

execute(['scrapy','crawl','chouti']) # 设置了日志级别

配置文件目录介绍

-crawl_chouti # 项目名

-crawl_chouti # 跟项目一个名,文件夹

-spiders # spiders:放着爬虫 genspider生成的爬虫,都放在这下面

-__init__.py

-chouti.py # 抽屉爬虫

-cnblogs.py # cnblogs 爬虫

-items.py # 对比django中的models.py文件 ,写一个个的模型类

-middlewares.py # 中间件(爬虫中间件,下载中间件),中间件写在这

-pipelines.py # 写持久化的地方(持久化到文件,mysql,redis,mongodb)

-settings.py # 配置文件

-scrapy.cfg # 不用关注,上线相关的

# 配置文件settings.py

ROBOTSTXT_OBEY = False # 是否遵循爬虫协议,强行运行

USER_AGENT = 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.149 Safari/537.36' # 请求头中的ua,去浏览器复制,或者用ua池拿

LOG_LEVEL='ERROR' # 这样配置,程序错误信息才会打印,

#启动爬虫直接 scrapy crawl 爬虫名 就没有日志输出

# scrapy crawl 爬虫名 --nolog # 配置了就不需要这样启动了

# 爬虫文件

class ChoutiSpider(scrapy.Spider):

name = 'chouti' # 爬虫名字

allowed_domains = ['https://dig.chouti.com/'] # 允许爬取的域,想要多爬就注释掉

start_urls = ['https://dig.chouti.com/'] # 起始爬取的位置,爬虫一启动,会先向它发请求

def parse(self, response): # 解析,请求回来,自动执行parser,在这个方法中做解析

print('---------------------------',response)

抓取数据并解析

# 1 解析,可以使用bs4解析

from bs4 import BeautifulSoup

soup=BeautifulSoup(response.text,'lxml')

soup.find_all() # bs4解析

soup.select() # css解析

# 2 内置的解析器

response.css

response.xpath

# 内置解析

# 所有用css或者xpath选择出来的都放在列表中

# 取第一个:extract_first()

# 取出所有extract()

# css选择器取文本和属性:

# .link-title::text # 取文本,数据都在data中

# .link-title::attr(href) # 取属性,数据都在data中

# xpath选择器取文本和属性

# .//a[contains(@class,"link-title")/text()]

#.//a[contains(@class,"link-title")/@href]

# 内置css选择期,取所有

div_list = response.css('.link-con .link-item')

for div in div_list:

content = div.css('.link-title').extract()

print(content)

数据持久化

# 方式一(不推荐)

-1 parser解析函数,return 列表,列表套字典

# 命令 (支持:('json', 'jsonlines', 'jl', 'csv', 'xml', 'marshal', 'pickle')

# 数据到aa.json文件中

-2 scrapy crawl chouti -o aa.json

# 代码:

lis = []

for div in div_list:

content = div.select('.link-title')[0].text

lis.append({'title':content})

return lis

# 方式二 pipline的方式(管道)

-1 在items.py中创建模型类

-2 在爬虫中chouti.py,引入,把解析的数据放到item对象中(要用中括号)

-3 yield item对象

-4 配置文件配置管道

ITEM_PIPELINES = {

# 数字表示优先级(数字越小,优先级越大)

'crawl_chouti.pipelines.CrawlChoutiPipeline': 300,

'crawl_chouti.pipelines.CrawlChoutiRedisPipeline': 301,

}

-5 pipline.py中写持久化的类

spider_open # 方法,一开始就打开文件

process_item # 方法,写入文件

spider_close # 方法,关闭文件

保存到文件

# choutiaa.py 爬虫文件

import scrapy

from chouti.items import ChoutiItem # 导入模型类

class ChoutiaaSpider(scrapy.Spider):

name = 'choutiaa'

# allowed_domains = ['https://dig.chouti.com/'] # 允许爬取的域

start_urls = ['https://dig.chouti.com//'] # 起始爬取位置

# 解析,请求回来,自动执行parse,在这个方法中解析

def parse(self, response):

print('----------------',response)

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text,'lxml')

div_list = soup.select('.link-con .link-item')

for div in div_list:

content = div.select('.link-title')[0].text

href = div.select('.link-title')[0].attrs['href']

item = ChoutiItem() # 生成模型对象

item['content'] = content # 添加值

item['href'] = href

yield item # 必须用yield

# items.py 模型类文件

import scrapy

class ChoutiItem(scrapy.Item):

content = scrapy.Field()

href = scrapy.Field()

# pipelines.py 数据持久化文件

class ChoutiPipeline(object):

def open_spider(self, spider):

# 一开始就打开文件

self.f = open('a.txt', 'w', encoding='utf-8')

def process_item(self, item, spider):

# print(item)

# 写入文件的操作 查看全部

文章采集api(Scrapy一个

)

内容

架构介绍

Scrapy 是一个开源和协作框架,最初是为页面抓取(更准确地说是网页抓取)而设计的,它允许您以快速、简单和可扩展的方式从所需数据中提取所有信息。但目前,Scrapy 的用途非常广泛,例如数据挖掘、监控和自动化测试,也可以用来获取 API(例如 Amazon Associates Web Services)或一般网络爬虫返回的数据。

Scrapy 是基于 twisted 框架开发的,这是一个流行的事件驱动的 Python 网络框架。所以 Scrapy 使用非阻塞(又名异步)代码来实现并发。整体结构大致如下

IO多路复用

# 引擎(EGINE)(大总管)

引擎负责控制系统所有组件之间的数据流,并在某些动作发生时触发事件。有关详细信息,请参见上面的数据流部分。

# 调度器(SCHEDULER)

用来接受引擎发过来的请求, 压入队列中, 并在引擎再次请求的时候返回. 可以想像成一个URL的优先级队列, 由它来决定下一个要抓取的网址是什么, 同时去除重复的网址

# 下载器(DOWLOADER)

用于下载网页内容, 并将网页内容返回给EGINE,下载器是建立在twisted这个高效的异步模型上的

# 爬虫(SPIDERS)

SPIDERS是开发人员自定义的类,用来解析responses,并且提取items,或者发送新的请求

# 项目管道(ITEM PIPLINES)

在items被提取后负责处理它们,主要包括清理、验证、持久化(比如存到数据库)等操作

# 两个中间件

-爬虫中间件

-下载中间件(用的最多,加头,加代理,加cookie,集成selenium)

安装创建和启动

# 1 框架 不是 模块

# 2 号称爬虫界的django(你会发现,跟django很多地方一样)

# 3 安装

-mac,linux平台:pip3 install scrapy

-windows平台:pip3 install scrapy(大部分人可以)

- 如果失败:

1、pip3 install wheel #安装后,便支持通过wheel文件安装软件,wheel文件官网:https://www.lfd.uci.edu/~gohlke/pythonlibs

3、pip3 install lxml

4、pip3 install pyopenssl

5、下载并安装pywin32:https://sourceforge.net/projec ... in32/

6、下载twisted的wheel文件:http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted

7、执行pip3 install 下载目录\Twisted-17.9.0-cp36-cp36m-win_amd64.whl

8、pip3 install scrapy

# 4 在script文件夹下会有scrapy.exe可执行文件

-创建scrapy项目:scrapy startproject 项目名 (django创建项目)

-创建爬虫:scrapy genspider 爬虫名 要爬取的网站地址 # 可以创建多个爬虫

# 5 命令启动爬虫

-scrapy crawl 爬虫名字

-scrapy crawl 爬虫名字 --nolog # 没有日志输出启动

# 6 文件执行爬虫(推荐使用)

-在项目路径下创建一个main.py,右键执行即可

from scrapy.cmdline import execute

# execute(['scrapy','crawl','chouti','--nolog']) # 没有设置日志级别

execute(['scrapy','crawl','chouti']) # 设置了日志级别

配置文件目录介绍

-crawl_chouti # 项目名

-crawl_chouti # 跟项目一个名,文件夹

-spiders # spiders:放着爬虫 genspider生成的爬虫,都放在这下面

-__init__.py

-chouti.py # 抽屉爬虫

-cnblogs.py # cnblogs 爬虫

-items.py # 对比django中的models.py文件 ,写一个个的模型类

-middlewares.py # 中间件(爬虫中间件,下载中间件),中间件写在这

-pipelines.py # 写持久化的地方(持久化到文件,mysql,redis,mongodb)

-settings.py # 配置文件

-scrapy.cfg # 不用关注,上线相关的

# 配置文件settings.py

ROBOTSTXT_OBEY = False # 是否遵循爬虫协议,强行运行

USER_AGENT = 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.149 Safari/537.36' # 请求头中的ua,去浏览器复制,或者用ua池拿

LOG_LEVEL='ERROR' # 这样配置,程序错误信息才会打印,

#启动爬虫直接 scrapy crawl 爬虫名 就没有日志输出

# scrapy crawl 爬虫名 --nolog # 配置了就不需要这样启动了

# 爬虫文件

class ChoutiSpider(scrapy.Spider):

name = 'chouti' # 爬虫名字

allowed_domains = ['https://dig.chouti.com/'] # 允许爬取的域,想要多爬就注释掉

start_urls = ['https://dig.chouti.com/'] # 起始爬取的位置,爬虫一启动,会先向它发请求

def parse(self, response): # 解析,请求回来,自动执行parser,在这个方法中做解析

print('---------------------------',response)

抓取数据并解析

# 1 解析,可以使用bs4解析

from bs4 import BeautifulSoup

soup=BeautifulSoup(response.text,'lxml')

soup.find_all() # bs4解析

soup.select() # css解析

# 2 内置的解析器

response.css

response.xpath

# 内置解析

# 所有用css或者xpath选择出来的都放在列表中

# 取第一个:extract_first()

# 取出所有extract()

# css选择器取文本和属性:

# .link-title::text # 取文本,数据都在data中

# .link-title::attr(href) # 取属性,数据都在data中

# xpath选择器取文本和属性

# .//a[contains(@class,"link-title")/text()]

#.//a[contains(@class,"link-title")/@href]

# 内置css选择期,取所有

div_list = response.css('.link-con .link-item')

for div in div_list:

content = div.css('.link-title').extract()

print(content)

数据持久化

# 方式一(不推荐)

-1 parser解析函数,return 列表,列表套字典

# 命令 (支持:('json', 'jsonlines', 'jl', 'csv', 'xml', 'marshal', 'pickle')

# 数据到aa.json文件中

-2 scrapy crawl chouti -o aa.json

# 代码:

lis = []

for div in div_list:

content = div.select('.link-title')[0].text

lis.append({'title':content})

return lis

# 方式二 pipline的方式(管道)

-1 在items.py中创建模型类

-2 在爬虫中chouti.py,引入,把解析的数据放到item对象中(要用中括号)

-3 yield item对象

-4 配置文件配置管道

ITEM_PIPELINES = {

# 数字表示优先级(数字越小,优先级越大)

'crawl_chouti.pipelines.CrawlChoutiPipeline': 300,

'crawl_chouti.pipelines.CrawlChoutiRedisPipeline': 301,

}

-5 pipline.py中写持久化的类

spider_open # 方法,一开始就打开文件

process_item # 方法,写入文件

spider_close # 方法,关闭文件

保存到文件

# choutiaa.py 爬虫文件

import scrapy

from chouti.items import ChoutiItem # 导入模型类

class ChoutiaaSpider(scrapy.Spider):

name = 'choutiaa'

# allowed_domains = ['https://dig.chouti.com/'] # 允许爬取的域

start_urls = ['https://dig.chouti.com//'] # 起始爬取位置

# 解析,请求回来,自动执行parse,在这个方法中解析

def parse(self, response):

print('----------------',response)

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text,'lxml')

div_list = soup.select('.link-con .link-item')

for div in div_list:

content = div.select('.link-title')[0].text

href = div.select('.link-title')[0].attrs['href']

item = ChoutiItem() # 生成模型对象

item['content'] = content # 添加值

item['href'] = href

yield item # 必须用yield

# items.py 模型类文件

import scrapy

class ChoutiItem(scrapy.Item):

content = scrapy.Field()

href = scrapy.Field()

# pipelines.py 数据持久化文件

class ChoutiPipeline(object):

def open_spider(self, spider):

# 一开始就打开文件

self.f = open('a.txt', 'w', encoding='utf-8')

def process_item(self, item, spider):

# print(item)

# 写入文件的操作

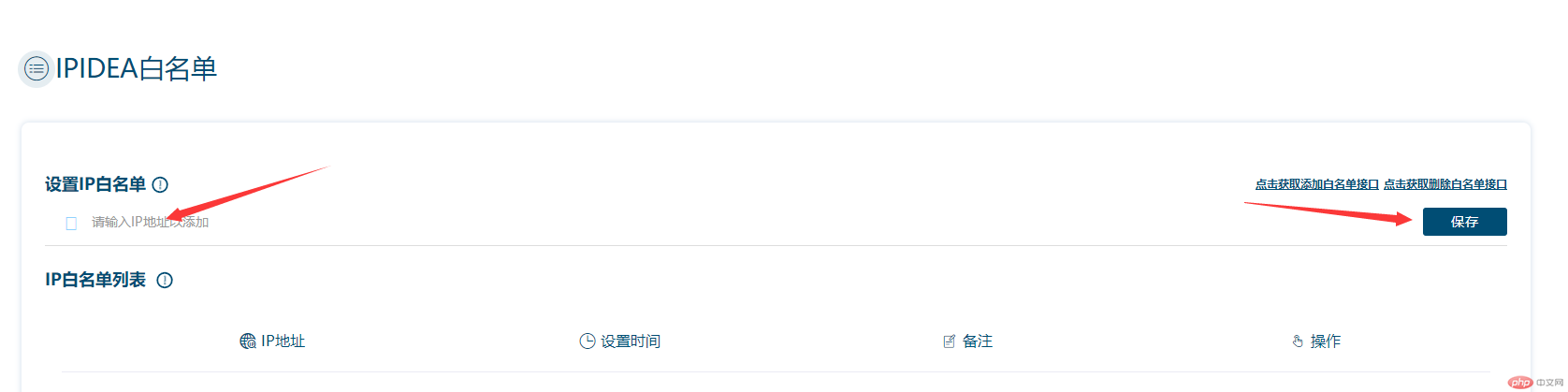

文章采集api( 爬虫海外网站获取ip之前,请检查是否添加白名单?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2022-02-21 19:03

爬虫海外网站获取ip之前,请检查是否添加白名单?)

海外网站如何使用代理IP采集?

我们在做爬虫的时候,经常会遇到这种情况。爬虫第一次运行时,可以正常获取数据,一切看起来都是那么美好。但是过一会可能会出现403 Forbidden,然后你会打开网站查看一下,你可能会看到“你的IP访问频率太高,请稍后再试”。遇到这种情况,通常这种情况下,我们会使用代理IP隐藏自己的IP,实现大量爬取。国内代理常用的产品有几十种,而我们需要在海外爬的时候网站这些代理都用不上,所以我们今天用的是Ipidea全球代理。

用法与国内相差不大。可以根据需要选择在指定国家或全球播放,通过api接口调用,指定提取次数,也可以指定接口返回数据格式,如txt、json、html、等等,这里以全局混合和json格式为例,获取一个代理,一次一个,python代码如下:

import requestsurl = "http://tiqu.linksocket.com:81/ ... Bresp = requests.get(url)# 成功获取到的数据为:{'code': 0, 'data': [{'ip': '47.74.232.57', 'port': 21861}], 'msg': '0', 'success': True}data = resp.json().get('data')[0]proxy = { "http": "http://%s:%d" % (data.get("ip"), data.get("port")), "https": "https://%s:%d" % (data.get("ip"), data.get("port"))}

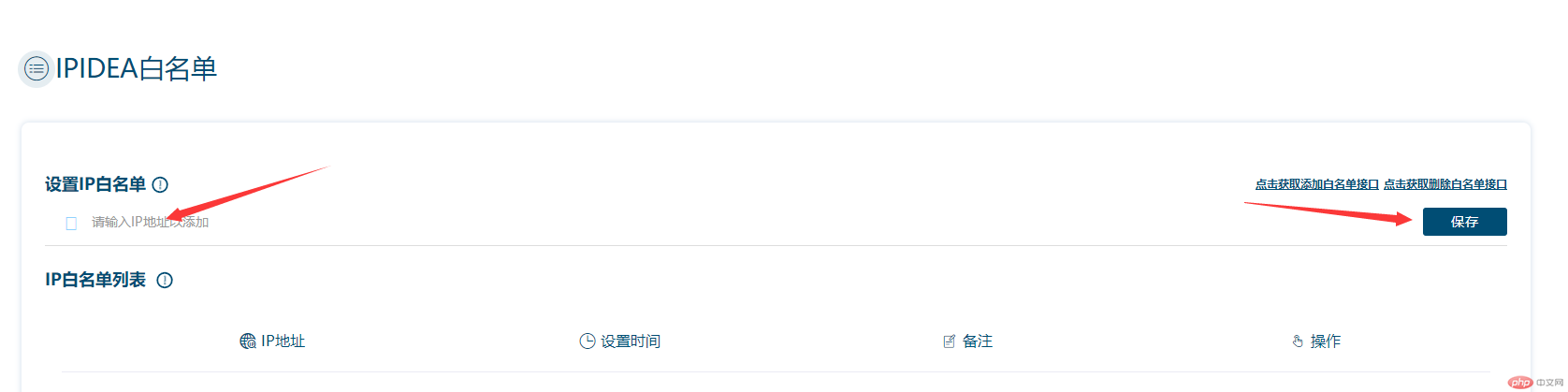

在获取IP之前,我们需要通过个人中心设置IP白名单,否则无法获取数据。

只需填写你本地的公网并保存即可(官方界面也提供了添加或删除白名单的界面)。如果不知道公网IP是什么,可以通过百度搜索IP。

爬虫演示如下。以下是六度新闻的示例:

import requestsurl = "http://tiqu.linksocket.com:81/ ... 3Bdef get_proxy(): """ 获取代理 """ resp = requests.get(url) data = resp.json().get('data')[0] proxy = { "http": "http://%s:%d" % (data.get("ip"), data.get("port")), "https": "https://%s:%d" % (data.get("ip"), data.get("port")) } return proxydef download_html(url): """ 获取url接口数据 """ resp = requests.get(url,proxies=get_proxy()) return resp.json()def run(): """ 主程序 :return: """ url = "https://6do.news/api/tag/114?page=1" content = download_html(url) # 数据处理略if __name__ == '__main__': run()

数据如图:

前后端分离的界面对爬虫比较友好,提取数据也比较方便。这里不需要做太多处理,可以根据需要提取数据。

如果代理不能挂在爬虫中,请检查是否添加白名单。

本次海外网站的采集教程到此结束,详细交流请联系我。

本文章仅供交流分享,【未经许可,请拒绝转载】 查看全部

文章采集api(

爬虫海外网站获取ip之前,请检查是否添加白名单?)

海外网站如何使用代理IP采集?

我们在做爬虫的时候,经常会遇到这种情况。爬虫第一次运行时,可以正常获取数据,一切看起来都是那么美好。但是过一会可能会出现403 Forbidden,然后你会打开网站查看一下,你可能会看到“你的IP访问频率太高,请稍后再试”。遇到这种情况,通常这种情况下,我们会使用代理IP隐藏自己的IP,实现大量爬取。国内代理常用的产品有几十种,而我们需要在海外爬的时候网站这些代理都用不上,所以我们今天用的是Ipidea全球代理。

用法与国内相差不大。可以根据需要选择在指定国家或全球播放,通过api接口调用,指定提取次数,也可以指定接口返回数据格式,如txt、json、html、等等,这里以全局混合和json格式为例,获取一个代理,一次一个,python代码如下:

import requestsurl = "http://tiqu.linksocket.com:81/ ... Bresp = requests.get(url)# 成功获取到的数据为:{'code': 0, 'data': [{'ip': '47.74.232.57', 'port': 21861}], 'msg': '0', 'success': True}data = resp.json().get('data')[0]proxy = { "http": "http://%s:%d" % (data.get("ip"), data.get("port")), "https": "https://%s:%d" % (data.get("ip"), data.get("port"))}

在获取IP之前,我们需要通过个人中心设置IP白名单,否则无法获取数据。

只需填写你本地的公网并保存即可(官方界面也提供了添加或删除白名单的界面)。如果不知道公网IP是什么,可以通过百度搜索IP。

爬虫演示如下。以下是六度新闻的示例:

import requestsurl = "http://tiqu.linksocket.com:81/ ... 3Bdef get_proxy(): """ 获取代理 """ resp = requests.get(url) data = resp.json().get('data')[0] proxy = { "http": "http://%s:%d" % (data.get("ip"), data.get("port")), "https": "https://%s:%d" % (data.get("ip"), data.get("port")) } return proxydef download_html(url): """ 获取url接口数据 """ resp = requests.get(url,proxies=get_proxy()) return resp.json()def run(): """ 主程序 :return: """ url = "https://6do.news/api/tag/114?page=1" content = download_html(url) # 数据处理略if __name__ == '__main__': run()

数据如图:

前后端分离的界面对爬虫比较友好,提取数据也比较方便。这里不需要做太多处理,可以根据需要提取数据。

如果代理不能挂在爬虫中,请检查是否添加白名单。

本次海外网站的采集教程到此结束,详细交流请联系我。

本文章仅供交流分享,【未经许可,请拒绝转载】

文章采集api(如何通过MySQL存储采集到的数据)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-02-21 06:08

MySQL是目前最流行的开源关系数据库管理系统。令人惊讶的是,一个开源项目的竞争力如此之强,以至于它的受欢迎程度不断接近另外两个闭源商业数据库系统:微软的 SQL Server 和甲骨文的甲骨文数据库(MySQL 于 2010 年被甲骨文收购)。)。

它的受欢迎程度不辜负它的名字。对于大多数应用程序,MySQL 是显而易见的选择。它是一个非常灵活、稳定、功能齐全的 DBMS,许多顶级 网站 都在使用它:Youtube、Twitter、Facebook 等。

由于使用广泛、免费、开箱即用,是web data采集项目中常用的数据库,在此文章我们介绍如何存储数据采集 通过 MySQL。

安装 MySQL

如果您是 MySQL 新手,您可能会觉得它有点麻烦。其实安装方法和安装其他软件一样简单。归根结底,MySQL 是由一系列数据文件组成的,存储在你的远程服务器或本地计算机上,其中收录了存储在数据库中的所有信息。

在Windows上安装MySQL,在Ubuntu上安装MySQL,在MAC上安装MySQL具体步骤在这里:在所有平台上安装MySQL

此处无需过多解释,按照视频操作即可。

基本命令

MySQL服务器启动后,与数据库服务器交互的方式有很多种。因为许多工具都是图形界面,所以您可以不使用 MySQL 的命令行(或很少使用)来管理数据库。phpMyAdmin 和 MySQL Workbench 等工具可以轻松查看、排序和创建数据库。但是,掌握命令行操作数据库还是很重要的。

除了用户定义的变量名,MySQL 不区分大小写。例如,SELECT 与 select 相同,但习惯上所有 MySQL 关键词 的 MySQL 语句都以大写形式编写。大多数开发人员还喜欢使用小写字母作为数据库和数据表名称。

首次登录 MySQL 数据库时,没有数据库来存储数据。我们需要创建一个数据库:

CREATE DATABASE scraping_article DEFAULT CHARACTER SET UTF8 COLLATE UTF8_GENERAL_CI;

因为每个 MySQL 实例可以有多个数据库,所以在使用数据库之前需要指定数据库名称:

使用scraping_article

从现在开始(直到关闭 MySQL 链接或切换到另一个数据库),所有命令都在这个新的“scraping_article”数据库中运行。

所有的操作看起来都很简单。那么在数据库中新建表的操作方法应该也差不多吧?我们在库中新建一个表来存储采集的网页文章的数据:

创建表文章;

结果显示错误:

错误 1113 (42000): 一个表必须至少有 1 列

与数据库不同,MySQL 数据表必须有列,否则无法创建。要在 MySQL 中定义字段(数据列),我们还必须将字段定义放在 CREATE TABLE 语句之后的带括号的逗号分隔列表中:

create table articles

(

id int auto_increment

primary key,

title varchar(64) null,

body text null,

summary varchar(256) null,

body_html text null,

create_time datetime default CURRENT_TIMESTAMP null,

time_updated datetime null,

link_text varchar(128) null

);

每个字段定义由三部分组成:

在字段定义列表的最后,还定义了一个“主键”(key)。MySQL使用这个主键来组织表的内容,方便以后快速查询。以后文章会介绍如何通过这些主键来提高数据库的查询速度,不过目前我们可以使用表的id列作为主键。

语句执行完毕后,我们可以使用DESCRIBE查看数据表的结构:

+--------------+--------------+------+-----+-------------------+----------------+

| Field | Type | Null | Key | Default | Extra |

+--------------+--------------+------+-----+-------------------+----------------+

| id | int(11) | NO | PRI | NULL | auto_increment |

| title | varchar(64) | YES | | NULL | |

| body | text | YES | | NULL | |

| summary | varchar(256) | YES | | NULL | |

| body_html | text | YES | | NULL | |

| create_time | datetime | YES | | CURRENT_TIMESTAMP | |

| time_updated | datetime | YES | | NULL | |

| link_text | varchar(128) | YES | | NULL | |

+--------------+--------------+------+-----+-------------------+----------------+

8 rows in set (0.03 sec)

现在这张表是空表,我们插入数据看看,如下图:

INSERT INTO articles(title,body,summary,body_html,link_text) VALUES ("Test page title","Test page body.","Test page summary.","<p>Test page body.","test-page");</p>

这里需要注意,虽然articles表有8个字段(id、title、body、summary、body_html、create_time、time_update、link_text),但实际上我们只插入了5个字段(title、body、summary、body_html、link_text) ) ) 数据。因为id字段是自动递增的(MySQL每次插入数据时默认递增1),一般不需要处理。另外create_time字段的类型是current_timestamp,时间戳是通过插入的默认。

当然,我们也可以自定义字段内容来插入数据:

INSERT INTO articles(id,title,body,summary,body_html,create_time,link_text) VALUES (4,"Test page title","Test page body.","Test page summary.","<p>Test page body.","2021-11-20 15:51:45","test-page");</p>

只要你定义的整数不在数据表的id字段中,就可以插入到数据表中。但是,这非常糟糕;除非绝对必要(比如程序中缺少一行数据),否则让 MySQL 自己处理 id 和 timestamp 字段。

现在表中有一些数据,我们可以通过多种方式查询这些数据。以下是 SELECT 语句的一些示例:

SELECT * FROM articles WHERE id=1;

该语句告诉 MySQL “从文章表中选择 id 等于 2 的所有数据”。此星号 (*) 是通配符,表示所有字段。这行语句将显示所有满足条件的字段(其中 id=1))。如果没有 id 等于 1 的行,它将返回一个空集。例如,以下不区分大小写的查询将返回标题字段中收录“test”的所有行的所有字段(% 符号表示 MySQL 字符串通配符):

SELECT * FROM articles WHERE title LIKE "%test%";

但是如果你有很多字段并且你只想返回其中的一部分呢?您可以使用以下命令代替星号:

SELECT title, body FROM articles WHERE body LIKE "%test%";

这将只返回正文内容收录“test”的所有行的标题和正文字段。

DELETE 语句的语法类似于 SELECT 语句:

DELETE FROM articles WHERE id=1;

由于数据库的数据删除无法恢复,建议在执行DELETE语句前使用SELECT确认要删除的数据(上述删除语句可以使用SELECT * FROM文章WHERE id=1;查看),以及然后将 SELECT * 替换为 DELETE 就可以了,这是一个好习惯。很多程序员都有过 DELETE 误操作的悲惨故事,也有一些恐怖的故事是有人惊慌失措的忘记在语句中输入 WHERE,结果所有客户数据都被删除了。不要让这种事情发生在你身上!

要介绍的另一件事是 UPDATE 语句:

UPDATE articles SET title="A new title", body="Some new body." WHERE id=4;

以上只使用了最基本的 MySQL 语句来做一些简单的数据查询、创建和更新。

与 Python 集成

Python 没有对 MySQL 的内置支持。但是,有很多开源的可以用来和 MySQL 交互,Python 2.x 和 Python 3.x 版本都支持。最著名的一个是 PyMySQL。

我们可以使用pip来安装,执行如下命令:

python3 -m pip 安装 PyMySQL

安装完成后,我们就可以使用 PyMySQL 包了。如果您的 MySQL 服务器正在运行,您应该能够成功执行以下命令:

import pymysql

import os

from dotenv import load_dotenv

class DataSaveToMySQL(object):

def __init__(self):

# loading env config file

dotenv_path = os.path.join(os.getcwd(), '.env')

if os.path.exists(dotenv_path):

load_dotenv(dotenv_path)

conn = pymysql.connect(host=os.environ.get('MYSQL_HOST'), port=os.environ.get('MYSQL_PORT'),

user=os.environ.get('MYSQL_USER'), password=os.environ.get('MYSQL_PASSWORD'),

db=os.environ.get('MYSQL_DATABASES'))

cur = conn.cursor()

cur.execute("SELECT * FROM articles WHERE id=4;")

print(cur.fetchone())

cur.close()

conn.close()

这个程序有两个对象:一个连接对象(conn)和一个游标对象(cur)。

连接/游标模式是数据库编程中常用的模式。当您不熟悉数据库时,有时很难区分这两种模式之间的区别。连接方式除了连接数据库外,还发送数据库信息,处理回滚操作(当一个查询或一组查询中断时,数据库需要回到初始状态,一般使用事务来实现状态回滚),创建新游标等

一个连接可以有很多游标,一个游标跟踪一种状态信息,比如跟踪数据库的使用状态。如果您有多个数据库,并且需要写入所有数据库,则需要多个游标来处理。游标还可以收录上次查询执行的结果。查询结果可以通过调用cur.fetchone()等游标函数获得。

请记住在使用完连接和游标后关闭它们。如果不关闭,会导致连接泄漏(connection leak),造成连接关闭现象,即连接不再使用,但是数据库无法关闭,因为数据库不确定是否你想继续使用它。这种现象会一直消耗数据库资源,所以使用数据库后记得关闭连接!

刚开始时,您要做的就是将 采集 的数据保存到数据库中。我们继续采集blog文章的例子来演示如何实现数据存储。

import pymysql

import os

from dotenv import load_dotenv

from config import logger_config

from utils import connection_util

class DataSaveToMySQL(object):

def __init__(self):

# loading env config file

dotenv_path = os.path.join(os.getcwd(), '.env')

if os.path.exists(dotenv_path):

load_dotenv(dotenv_path)

# MySQL config

self._host = os.environ.get('MYSQL_HOST')

self._port = int(os.environ.get('MYSQL_PORT'))

self._user = os.environ.get('MYSQL_USER')

self._password = os.environ.get('MYSQL_PASSWORD')

self._db = os.environ.get('MYSQL_DATABASES')

self._target_url = 'https://www.scrapingbee.com/blog/'

self._baseUrl = 'https://www.scrapingbee.com'

self._init_connection = connection_util.ProcessConnection()

logging_name = 'store_mysql'

init_logging = logger_config.LoggingConfig()

self._logging = init_logging.init_logging(logging_name)

def scrape_data(self):

get_content = self._init_connection.init_connection(self._target_url)

if get_content:

parent = get_content.findAll("section", {"class": "section-sm"})[0]

get_row = parent.findAll("div", {"class": "col-lg-12 mb-5 mb-lg-0"})[0]

get_child_item = get_row.findAll("div", {"class": "col-md-4 mb-4"})

for item in get_child_item:

# 获取标题文字

get_title = item.find("a", {"class": "h5 d-block mb-3 post-title"}).get_text()

# 获取发布时间

get_release_date = item.find("div", {"class": "mb-3 mt-2"}).findAll("span")[1].get_text()

# 获取文章描述

get_description = item.find("p", {"class": "card-text post-description"}).get_text()

self.article_save_mysql(title=get_title, description=get_description, release_date=get_release_date)

else:

self._logging.warning('未获取到文章任何内容,请检查!')

def article_save_mysql(self, title, description, release_date):

connection = pymysql.connect(host=self._host, port=self._port, user=self._user, password=self._password,

db=self._db, charset='utf-8')

with connection.cursor() as cursor:

# Create a new record

sql = "INSERT INTO articles (title,summary,create_time) VALUES (%s,%s,%s);"

cursor.execute(sql, (title, description, release_date))

# connection is not autocommit by default. So you must commit to save

# your changes.

connection.commit()

这里需要注意几点:首先,将 charset='utf-8' 添加到连接字符串中。这是为了让conn把所有发送到数据库的信息都当作utf-8编码格式(当然前提是数据库默认编码设置为UTF-8)。

然后需要注意article_save_mysql函数。它有3个参数:title、description和release_date,并将这两个参数添加到INSERT语句中并用游标执行,然后用游标确认。这是将光标与连接分开的一个很好的例子;当游标存储一些数据库和数据库上下文信息时,需要通过连接确认才能将信息传递到数据库中,然后再将信息插入到数据库中。

上述代码没有使用 try...finally 语句关闭数据库,而是使用 with() 关闭数据库连接。在上一期中,我们也使用了 with() 来关闭 CSV 文件。

PyMySQL的规模虽然不大,但里面有一些非常实用的功能,在本文章中就不演示了。具体请参考 Python DBAPI 标准文档。

以上是关于将采集的内容保存到MySQL。本示例的所有代码都托管在 github 上。

github: 查看全部

文章采集api(如何通过MySQL存储采集到的数据)

MySQL是目前最流行的开源关系数据库管理系统。令人惊讶的是,一个开源项目的竞争力如此之强,以至于它的受欢迎程度不断接近另外两个闭源商业数据库系统:微软的 SQL Server 和甲骨文的甲骨文数据库(MySQL 于 2010 年被甲骨文收购)。)。

它的受欢迎程度不辜负它的名字。对于大多数应用程序,MySQL 是显而易见的选择。它是一个非常灵活、稳定、功能齐全的 DBMS,许多顶级 网站 都在使用它:Youtube、Twitter、Facebook 等。

由于使用广泛、免费、开箱即用,是web data采集项目中常用的数据库,在此文章我们介绍如何存储数据采集 通过 MySQL。

安装 MySQL

如果您是 MySQL 新手,您可能会觉得它有点麻烦。其实安装方法和安装其他软件一样简单。归根结底,MySQL 是由一系列数据文件组成的,存储在你的远程服务器或本地计算机上,其中收录了存储在数据库中的所有信息。

在Windows上安装MySQL,在Ubuntu上安装MySQL,在MAC上安装MySQL具体步骤在这里:在所有平台上安装MySQL

此处无需过多解释,按照视频操作即可。

基本命令

MySQL服务器启动后,与数据库服务器交互的方式有很多种。因为许多工具都是图形界面,所以您可以不使用 MySQL 的命令行(或很少使用)来管理数据库。phpMyAdmin 和 MySQL Workbench 等工具可以轻松查看、排序和创建数据库。但是,掌握命令行操作数据库还是很重要的。

除了用户定义的变量名,MySQL 不区分大小写。例如,SELECT 与 select 相同,但习惯上所有 MySQL 关键词 的 MySQL 语句都以大写形式编写。大多数开发人员还喜欢使用小写字母作为数据库和数据表名称。

首次登录 MySQL 数据库时,没有数据库来存储数据。我们需要创建一个数据库:

CREATE DATABASE scraping_article DEFAULT CHARACTER SET UTF8 COLLATE UTF8_GENERAL_CI;

因为每个 MySQL 实例可以有多个数据库,所以在使用数据库之前需要指定数据库名称:

使用scraping_article

从现在开始(直到关闭 MySQL 链接或切换到另一个数据库),所有命令都在这个新的“scraping_article”数据库中运行。

所有的操作看起来都很简单。那么在数据库中新建表的操作方法应该也差不多吧?我们在库中新建一个表来存储采集的网页文章的数据:

创建表文章;

结果显示错误:

错误 1113 (42000): 一个表必须至少有 1 列

与数据库不同,MySQL 数据表必须有列,否则无法创建。要在 MySQL 中定义字段(数据列),我们还必须将字段定义放在 CREATE TABLE 语句之后的带括号的逗号分隔列表中:

create table articles

(

id int auto_increment

primary key,

title varchar(64) null,

body text null,

summary varchar(256) null,

body_html text null,

create_time datetime default CURRENT_TIMESTAMP null,

time_updated datetime null,

link_text varchar(128) null

);

每个字段定义由三部分组成:

在字段定义列表的最后,还定义了一个“主键”(key)。MySQL使用这个主键来组织表的内容,方便以后快速查询。以后文章会介绍如何通过这些主键来提高数据库的查询速度,不过目前我们可以使用表的id列作为主键。

语句执行完毕后,我们可以使用DESCRIBE查看数据表的结构:

+--------------+--------------+------+-----+-------------------+----------------+

| Field | Type | Null | Key | Default | Extra |

+--------------+--------------+------+-----+-------------------+----------------+

| id | int(11) | NO | PRI | NULL | auto_increment |

| title | varchar(64) | YES | | NULL | |

| body | text | YES | | NULL | |

| summary | varchar(256) | YES | | NULL | |

| body_html | text | YES | | NULL | |

| create_time | datetime | YES | | CURRENT_TIMESTAMP | |

| time_updated | datetime | YES | | NULL | |

| link_text | varchar(128) | YES | | NULL | |

+--------------+--------------+------+-----+-------------------+----------------+

8 rows in set (0.03 sec)

现在这张表是空表,我们插入数据看看,如下图:

INSERT INTO articles(title,body,summary,body_html,link_text) VALUES ("Test page title","Test page body.","Test page summary.","<p>Test page body.","test-page");</p>

这里需要注意,虽然articles表有8个字段(id、title、body、summary、body_html、create_time、time_update、link_text),但实际上我们只插入了5个字段(title、body、summary、body_html、link_text) ) ) 数据。因为id字段是自动递增的(MySQL每次插入数据时默认递增1),一般不需要处理。另外create_time字段的类型是current_timestamp,时间戳是通过插入的默认。

当然,我们也可以自定义字段内容来插入数据:

INSERT INTO articles(id,title,body,summary,body_html,create_time,link_text) VALUES (4,"Test page title","Test page body.","Test page summary.","<p>Test page body.","2021-11-20 15:51:45","test-page");</p>

只要你定义的整数不在数据表的id字段中,就可以插入到数据表中。但是,这非常糟糕;除非绝对必要(比如程序中缺少一行数据),否则让 MySQL 自己处理 id 和 timestamp 字段。

现在表中有一些数据,我们可以通过多种方式查询这些数据。以下是 SELECT 语句的一些示例:

SELECT * FROM articles WHERE id=1;

该语句告诉 MySQL “从文章表中选择 id 等于 2 的所有数据”。此星号 (*) 是通配符,表示所有字段。这行语句将显示所有满足条件的字段(其中 id=1))。如果没有 id 等于 1 的行,它将返回一个空集。例如,以下不区分大小写的查询将返回标题字段中收录“test”的所有行的所有字段(% 符号表示 MySQL 字符串通配符):

SELECT * FROM articles WHERE title LIKE "%test%";

但是如果你有很多字段并且你只想返回其中的一部分呢?您可以使用以下命令代替星号:

SELECT title, body FROM articles WHERE body LIKE "%test%";

这将只返回正文内容收录“test”的所有行的标题和正文字段。

DELETE 语句的语法类似于 SELECT 语句:

DELETE FROM articles WHERE id=1;

由于数据库的数据删除无法恢复,建议在执行DELETE语句前使用SELECT确认要删除的数据(上述删除语句可以使用SELECT * FROM文章WHERE id=1;查看),以及然后将 SELECT * 替换为 DELETE 就可以了,这是一个好习惯。很多程序员都有过 DELETE 误操作的悲惨故事,也有一些恐怖的故事是有人惊慌失措的忘记在语句中输入 WHERE,结果所有客户数据都被删除了。不要让这种事情发生在你身上!

要介绍的另一件事是 UPDATE 语句:

UPDATE articles SET title="A new title", body="Some new body." WHERE id=4;

以上只使用了最基本的 MySQL 语句来做一些简单的数据查询、创建和更新。

与 Python 集成

Python 没有对 MySQL 的内置支持。但是,有很多开源的可以用来和 MySQL 交互,Python 2.x 和 Python 3.x 版本都支持。最著名的一个是 PyMySQL。

我们可以使用pip来安装,执行如下命令:

python3 -m pip 安装 PyMySQL

安装完成后,我们就可以使用 PyMySQL 包了。如果您的 MySQL 服务器正在运行,您应该能够成功执行以下命令:

import pymysql

import os

from dotenv import load_dotenv

class DataSaveToMySQL(object):

def __init__(self):

# loading env config file

dotenv_path = os.path.join(os.getcwd(), '.env')

if os.path.exists(dotenv_path):

load_dotenv(dotenv_path)

conn = pymysql.connect(host=os.environ.get('MYSQL_HOST'), port=os.environ.get('MYSQL_PORT'),

user=os.environ.get('MYSQL_USER'), password=os.environ.get('MYSQL_PASSWORD'),

db=os.environ.get('MYSQL_DATABASES'))

cur = conn.cursor()

cur.execute("SELECT * FROM articles WHERE id=4;")

print(cur.fetchone())

cur.close()

conn.close()

这个程序有两个对象:一个连接对象(conn)和一个游标对象(cur)。

连接/游标模式是数据库编程中常用的模式。当您不熟悉数据库时,有时很难区分这两种模式之间的区别。连接方式除了连接数据库外,还发送数据库信息,处理回滚操作(当一个查询或一组查询中断时,数据库需要回到初始状态,一般使用事务来实现状态回滚),创建新游标等

一个连接可以有很多游标,一个游标跟踪一种状态信息,比如跟踪数据库的使用状态。如果您有多个数据库,并且需要写入所有数据库,则需要多个游标来处理。游标还可以收录上次查询执行的结果。查询结果可以通过调用cur.fetchone()等游标函数获得。

请记住在使用完连接和游标后关闭它们。如果不关闭,会导致连接泄漏(connection leak),造成连接关闭现象,即连接不再使用,但是数据库无法关闭,因为数据库不确定是否你想继续使用它。这种现象会一直消耗数据库资源,所以使用数据库后记得关闭连接!

刚开始时,您要做的就是将 采集 的数据保存到数据库中。我们继续采集blog文章的例子来演示如何实现数据存储。

import pymysql

import os

from dotenv import load_dotenv

from config import logger_config

from utils import connection_util

class DataSaveToMySQL(object):

def __init__(self):

# loading env config file

dotenv_path = os.path.join(os.getcwd(), '.env')

if os.path.exists(dotenv_path):

load_dotenv(dotenv_path)

# MySQL config

self._host = os.environ.get('MYSQL_HOST')

self._port = int(os.environ.get('MYSQL_PORT'))

self._user = os.environ.get('MYSQL_USER')

self._password = os.environ.get('MYSQL_PASSWORD')

self._db = os.environ.get('MYSQL_DATABASES')

self._target_url = 'https://www.scrapingbee.com/blog/'

self._baseUrl = 'https://www.scrapingbee.com'

self._init_connection = connection_util.ProcessConnection()

logging_name = 'store_mysql'

init_logging = logger_config.LoggingConfig()

self._logging = init_logging.init_logging(logging_name)

def scrape_data(self):

get_content = self._init_connection.init_connection(self._target_url)

if get_content:

parent = get_content.findAll("section", {"class": "section-sm"})[0]

get_row = parent.findAll("div", {"class": "col-lg-12 mb-5 mb-lg-0"})[0]

get_child_item = get_row.findAll("div", {"class": "col-md-4 mb-4"})

for item in get_child_item:

# 获取标题文字

get_title = item.find("a", {"class": "h5 d-block mb-3 post-title"}).get_text()

# 获取发布时间

get_release_date = item.find("div", {"class": "mb-3 mt-2"}).findAll("span")[1].get_text()

# 获取文章描述

get_description = item.find("p", {"class": "card-text post-description"}).get_text()

self.article_save_mysql(title=get_title, description=get_description, release_date=get_release_date)

else:

self._logging.warning('未获取到文章任何内容,请检查!')

def article_save_mysql(self, title, description, release_date):

connection = pymysql.connect(host=self._host, port=self._port, user=self._user, password=self._password,

db=self._db, charset='utf-8')

with connection.cursor() as cursor:

# Create a new record

sql = "INSERT INTO articles (title,summary,create_time) VALUES (%s,%s,%s);"

cursor.execute(sql, (title, description, release_date))

# connection is not autocommit by default. So you must commit to save

# your changes.

connection.commit()

这里需要注意几点:首先,将 charset='utf-8' 添加到连接字符串中。这是为了让conn把所有发送到数据库的信息都当作utf-8编码格式(当然前提是数据库默认编码设置为UTF-8)。

然后需要注意article_save_mysql函数。它有3个参数:title、description和release_date,并将这两个参数添加到INSERT语句中并用游标执行,然后用游标确认。这是将光标与连接分开的一个很好的例子;当游标存储一些数据库和数据库上下文信息时,需要通过连接确认才能将信息传递到数据库中,然后再将信息插入到数据库中。

上述代码没有使用 try...finally 语句关闭数据库,而是使用 with() 关闭数据库连接。在上一期中,我们也使用了 with() 来关闭 CSV 文件。

PyMySQL的规模虽然不大,但里面有一些非常实用的功能,在本文章中就不演示了。具体请参考 Python DBAPI 标准文档。

以上是关于将采集的内容保存到MySQL。本示例的所有代码都托管在 github 上。

github:

文章采集api(【干货】Kubernetes日志采集难点分析(一)——Kubernetes)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-02-21 06:02

前言

上一期主要介绍了Kubernetes日志输出的一些注意事项。日志输出的最终目的是做统一的采集和分析。在 Kubernetes 中,记录采集的方式与普通虚拟机有很大不同,相对实现难度和部署成本也略高。但是,如果使用得当,可以实现比传统方式更高的自动化程度和更低的运维成本。

Kubernetes 日志采集 难点

在 Kubernetes 中,log采集 比传统的虚拟机和物理机要复杂得多。最根本的原因是Kubernetes屏蔽了底层异常,提供了更细粒度的资源调度,向上提供了一个稳定动态的环境。因此,日志采集面临着更丰富、更动态的环境,需要考虑的点也更多。

例如:

对于一个运行时间很短的Job应用,从启动到停止只需要几秒,如何保证日志采集的实时性能跟得上,数据不丢失?K8s 一般推荐使用大型节点。每个节点可以运行 10-100+ 个容器。如何以尽可能低的资源消耗采集100+ 个容器?在K8s中,应用以yaml的形式部署,日志采集主要是手动配置文件的形式。日志采集如何以K8s的方式部署?

Kubernetes传统日志类型文件、stdout、host文件、journal文件、journal日志源业务容器、系统组件、宿主业务、宿主采集方法代理(Sidecar、DaemonSet)、直写(DockerEngine、业务)代理、直接-write 单机应用号 10-1001-10 应用动态高低 节点动态高低 采集 部署方式手动、Yaml手动、自定义

采集模式:主动或被动

日志采集方法有两种:被动采集和主动推送。在K8s中,被动采集一般分为Sidecar和DaemonSet两种方式。主动推送包括 DockerEngine 推送和业务直推。写两种方式。

总结:DockerEngine直接写一般不推荐;日志量大的场景推荐业务直写;DaemonSet 一般用于中小型集群;建议在非常大的集群中使用 Sidecar。各种采集方法的详细对比如下:

DockerEngine业务直接写入DaemonSet方法Sidecar方法采集日志类型标准输出业务日志标准输出+部分文件文件部署运维低,原生支持低,只需要维护配置文件正常,需要为了维护 DaemonSet 高,每个需要 采集 日志的 POD 都需要部署一个 sidecar 容器。日志分类和存储无法实现业务无关的配置。一般来说,每个POD都可以通过容器/路径映射来单独配置,灵活性高,多租户隔离性较弱。日志直写一般会和业务逻辑竞争资源。只能通过强配置隔离,通过容器隔离,资源可独立分配,支持集群规模无限本地存储。如果使用 syslog 和 fluentd,根据配置会有单点限制和无限制。无限资源数量低,dockerengine提供整体最低,节省采集的成本,每个节点运行一个容器高,每个POD运行一个容器,查询便利性低,只有grep raw日志高,可根据业务特点定制高,可定制查询,高统计,可根据业务特点定制低高可定制性,可自由扩展低高,每个POD单独配置高耦合,并且强绑定 DockerEngine 固定,修改需要重启 DockerEngine 高,<

日志输出:标准输出或文件

与虚拟机/物理机不同,K8s 容器提供标准输出和文件。在容器中,标准输出直接将日志输出到stdout或stderr,DockerEngine接管stdout和stderr文件描述符,收到日志后根据DockerEngine配置的LogDriver规则进行处理;日志打印到文件的方式与虚拟机/物理机不同。基本类似,只是日志可以使用不同的存储方式,比如默认存储、EmptyDir、HostVolume、NFS等。

虽然 Docker 官方推荐使用 Stdout 打印日志,但需要注意的是,这个推荐是基于容器仅作为简单应用使用的场景。在实际业务场景中,我们还是建议大家尽量使用文件方式。主要原因如下。观点:

stdout性能问题,从应用输出stdout到服务器,会有几个过程(比如常用的JSON LogDriver):应用stdout -> DockerEngine -> LogDriver -> 序列化成JSON -> 保存到文件 -> Agent< @采集文件 -> 解析 JSON -> 上传服务器。整个过程需要比文件更多的开销。压力测试时,每秒输出 10 万行日志会占用 DockerEngine 的额外 CPU 内核。stdout 不支持分类,即所有输出混合在一个流中,不能像文件一样分类输出。通常,一个应用程序包括AccessLog、ErrorLog、InterfaceLog(调用外部接口的日志)、TraceLog等。这些日志的格式和用途不,会很难采集 如果在同一流中混合,则进行分析。stdout 只支持容器主程序的输出。如果是 daemon/fork 模式下运行的程序,则无法使用 stdout。文件转储方式支持多种策略,如同步/异步写入、缓存大小、文件轮换策略、压缩策略、清除策略等,相对更加灵活。

因此,我们建议在线应用使用文件输出日志,而Stdout仅用于功能单一或部分K8s系统/运维组件的应用。

CICD 集成:日志记录操作员

Kubernetes提供了标准化的业务部署方式,可以通过yaml(K8s API)声明路由规则、暴露服务、挂载存储、运行业务、定义伸缩规则等,因此Kubernetes很容易与CICD系统集成。日志采集也是运维监控过程的重要组成部分。必须实时采集业务上线后的所有日志。

原来的方法是在发布后手动部署log采集的逻辑。这种方式需要人工干预,违背了CICD自动化的目的;为了实现自动化,已经有人开始基于日志包装API/SDK采集一个自动部署的服务,发布后通过CICD的webhook触发调用,但是这种方式开发成本高。

在 Kubernetes 中,集成日志最标准的方式是在 Kubernetes 系统中注册一个新资源,并以 Operator(CRD)的形式对其进行管理和维护。这样CICD系统就不需要额外开发,部署到Kubernetes系统时只需要附加日志相关的配置即可。

Kubernetes 日志采集 方案

早在 Kubernetes 出现之前,我们就开始为容器环境开发 log采集 解决方案。随着K8s的逐渐稳定,我们开始将很多业务迁移到K8s平台上,所以我们也在之前的基础上开发了一套。K8s 上的 log采集 方案。主要功能有:

支持各种数据的实时采集,包括容器文件、容器Stdout、宿主文件、Journal、Event等;支持多种采集部署方式,包括DaemonSet、Sidecar、DockerEngine LogDriver等;日志数据丰富,包括Namespace、Pod、Container、Image、Node等附加信息;稳定高可靠,基于阿里巴巴自研Logtail采集Agent实现。目前,全网部署实例数以百万计。; 基于CRD扩展,日志采集规则可以以Kubernetes部署发布的方式部署,与CICD完美集成。

安装日志采集组件

目前,这个采集解决方案已经对外开放。我们提供 Helm 安装包,收录 Logtail 的 DaemonSet、AliyunlogConfig 的 CRD 声明和 CRD Controller。安装后直接使用DaemonS优采云采集器即可,CRD配置完毕。安装方法如下:

阿里云Kubernetes集群在激活的时候就可以安装,这样在创建集群的时候会自动安装以上的组件。如果激活的时候没有安装,可以手动安装。如果是自建Kubernetes,无论是自建在阿里云上还是在其他云上还是离线,都可以使用这个采集方案。具体安装方法请参考【自建Kubernetes安装】()。

上述组件安装完成后,Logtail和对应的Controller会在集群中运行,但默认这些组件不会采集任何日志,需要配置日志采集规则为采集@ > 指定各种日志的Pod。

采集规则配置:环境变量或CRD

除了在日志服务控制台手动配置外,Kubernetes 还支持另外两种配置方式:环境变量和 CRD。

环境变量是自swarm时代以来一直使用的配置方式。你只需要在你想要采集的容器环境变量上声明需要采集的数据地址,Logtail会自动采集这个数据>到服务器。该方法部署简单,学习成本低,易于使用;但是可以支持的配置规则很少,很多高级配置(如解析方式、过滤方式、黑白名单等)都不支持,而且这种声明方式也不支持修改/删除,每个修改实际上创建了一个新的 采集 配置。历史采集配置需要手动清理,否则会造成资源浪费。

CRD的配置方式非常符合Kubernetes官方推荐的标准扩展方式,允许采集配置以K8s资源的形式进行管理,通过部署特殊的CRD资源AliyunLogConfig到Kubernetes来声明数据这需要 采集。例如,下面的例子是部署一个容器的标准输出采集,其中定义需要Stdout和Stderr 采集,并且排除环境变量收录COLLEXT_STDOUT_FLAG: false的容器。基于CRD的配置方式以Kubernetes标准扩展资源的方式进行管理,支持配置的完整语义的增删改查,支持各种高级配置。

采集推荐的规则配置方式

在实际应用场景中,一般使用 DaemonSet 或者 DaemonSet 和 Sidecar 的混合。DaemonSet 的优点是资源利用率高。但是存在一个问题,DaemonSet的所有Logtail共享全局配置,单个Logtail有配置支持上限。因此,它无法支持具有大量应用程序的集群。以上是我们给出的推荐配置方式。核心思想是:

一个尽可能多的采集相似数据的配置,减少了配置的数量,减轻了DaemonSet的压力;核心应用 采集 需要获得足够的资源,并且可以使用 Sidecar 方法;配置方式尽量使用CRD方式;Sidecar 由于每个Logtail都是独立配置的,所以配置数量没有限制,适用于非常大的集群。

练习 1 - 中小型集群

大多数 Kubernetes 集群都是中小型的。中小企业没有明确的定义。一般应用数量小于500,节点规模小于1000。没有功能清晰的Kubernetes平台运维。这个场景的应用数量不是特别多,DaemonSet可以支持所有的采集配置:

大部分业务应用的数据使用DaemonS优采云采集器方式,核心应用(对于可靠性要求较高的采集,如订单/交易系统)单独使用Sidecar方式采集 @>

练习 2 - 大型集群

对于一些用作PAAS平台的大型/超大型集群,一般业务在1000以上,节点规模也在1000以上。有专门的Kubernetes平台运维人员。这种场景下应用的数量没有限制,DaemonSet 无法支持。因此,必须使用 Sidecar 方法。总体规划如下:

Kubernetes平台的系统组件日志和内核日志的类型是比较固定的。这部分日志使用了DaemonS优采云采集器,主要为平台的运维人员提供服务;每个业务的日志使用Sidecar方式采集,每个业务可以独立设置Sidecar的采集目的地址,为业务的DevOps人员提供了足够的灵活性。 查看全部

文章采集api(【干货】Kubernetes日志采集难点分析(一)——Kubernetes)

前言

上一期主要介绍了Kubernetes日志输出的一些注意事项。日志输出的最终目的是做统一的采集和分析。在 Kubernetes 中,记录采集的方式与普通虚拟机有很大不同,相对实现难度和部署成本也略高。但是,如果使用得当,可以实现比传统方式更高的自动化程度和更低的运维成本。

Kubernetes 日志采集 难点

在 Kubernetes 中,log采集 比传统的虚拟机和物理机要复杂得多。最根本的原因是Kubernetes屏蔽了底层异常,提供了更细粒度的资源调度,向上提供了一个稳定动态的环境。因此,日志采集面临着更丰富、更动态的环境,需要考虑的点也更多。

例如:

对于一个运行时间很短的Job应用,从启动到停止只需要几秒,如何保证日志采集的实时性能跟得上,数据不丢失?K8s 一般推荐使用大型节点。每个节点可以运行 10-100+ 个容器。如何以尽可能低的资源消耗采集100+ 个容器?在K8s中,应用以yaml的形式部署,日志采集主要是手动配置文件的形式。日志采集如何以K8s的方式部署?

Kubernetes传统日志类型文件、stdout、host文件、journal文件、journal日志源业务容器、系统组件、宿主业务、宿主采集方法代理(Sidecar、DaemonSet)、直写(DockerEngine、业务)代理、直接-write 单机应用号 10-1001-10 应用动态高低 节点动态高低 采集 部署方式手动、Yaml手动、自定义

采集模式:主动或被动

日志采集方法有两种:被动采集和主动推送。在K8s中,被动采集一般分为Sidecar和DaemonSet两种方式。主动推送包括 DockerEngine 推送和业务直推。写两种方式。

总结:DockerEngine直接写一般不推荐;日志量大的场景推荐业务直写;DaemonSet 一般用于中小型集群;建议在非常大的集群中使用 Sidecar。各种采集方法的详细对比如下:

DockerEngine业务直接写入DaemonSet方法Sidecar方法采集日志类型标准输出业务日志标准输出+部分文件文件部署运维低,原生支持低,只需要维护配置文件正常,需要为了维护 DaemonSet 高,每个需要 采集 日志的 POD 都需要部署一个 sidecar 容器。日志分类和存储无法实现业务无关的配置。一般来说,每个POD都可以通过容器/路径映射来单独配置,灵活性高,多租户隔离性较弱。日志直写一般会和业务逻辑竞争资源。只能通过强配置隔离,通过容器隔离,资源可独立分配,支持集群规模无限本地存储。如果使用 syslog 和 fluentd,根据配置会有单点限制和无限制。无限资源数量低,dockerengine提供整体最低,节省采集的成本,每个节点运行一个容器高,每个POD运行一个容器,查询便利性低,只有grep raw日志高,可根据业务特点定制高,可定制查询,高统计,可根据业务特点定制低高可定制性,可自由扩展低高,每个POD单独配置高耦合,并且强绑定 DockerEngine 固定,修改需要重启 DockerEngine 高,<

日志输出:标准输出或文件

与虚拟机/物理机不同,K8s 容器提供标准输出和文件。在容器中,标准输出直接将日志输出到stdout或stderr,DockerEngine接管stdout和stderr文件描述符,收到日志后根据DockerEngine配置的LogDriver规则进行处理;日志打印到文件的方式与虚拟机/物理机不同。基本类似,只是日志可以使用不同的存储方式,比如默认存储、EmptyDir、HostVolume、NFS等。

虽然 Docker 官方推荐使用 Stdout 打印日志,但需要注意的是,这个推荐是基于容器仅作为简单应用使用的场景。在实际业务场景中,我们还是建议大家尽量使用文件方式。主要原因如下。观点:

stdout性能问题,从应用输出stdout到服务器,会有几个过程(比如常用的JSON LogDriver):应用stdout -> DockerEngine -> LogDriver -> 序列化成JSON -> 保存到文件 -> Agent< @采集文件 -> 解析 JSON -> 上传服务器。整个过程需要比文件更多的开销。压力测试时,每秒输出 10 万行日志会占用 DockerEngine 的额外 CPU 内核。stdout 不支持分类,即所有输出混合在一个流中,不能像文件一样分类输出。通常,一个应用程序包括AccessLog、ErrorLog、InterfaceLog(调用外部接口的日志)、TraceLog等。这些日志的格式和用途不,会很难采集 如果在同一流中混合,则进行分析。stdout 只支持容器主程序的输出。如果是 daemon/fork 模式下运行的程序,则无法使用 stdout。文件转储方式支持多种策略,如同步/异步写入、缓存大小、文件轮换策略、压缩策略、清除策略等,相对更加灵活。

因此,我们建议在线应用使用文件输出日志,而Stdout仅用于功能单一或部分K8s系统/运维组件的应用。

CICD 集成:日志记录操作员

Kubernetes提供了标准化的业务部署方式,可以通过yaml(K8s API)声明路由规则、暴露服务、挂载存储、运行业务、定义伸缩规则等,因此Kubernetes很容易与CICD系统集成。日志采集也是运维监控过程的重要组成部分。必须实时采集业务上线后的所有日志。

原来的方法是在发布后手动部署log采集的逻辑。这种方式需要人工干预,违背了CICD自动化的目的;为了实现自动化,已经有人开始基于日志包装API/SDK采集一个自动部署的服务,发布后通过CICD的webhook触发调用,但是这种方式开发成本高。

在 Kubernetes 中,集成日志最标准的方式是在 Kubernetes 系统中注册一个新资源,并以 Operator(CRD)的形式对其进行管理和维护。这样CICD系统就不需要额外开发,部署到Kubernetes系统时只需要附加日志相关的配置即可。

Kubernetes 日志采集 方案

早在 Kubernetes 出现之前,我们就开始为容器环境开发 log采集 解决方案。随着K8s的逐渐稳定,我们开始将很多业务迁移到K8s平台上,所以我们也在之前的基础上开发了一套。K8s 上的 log采集 方案。主要功能有:

支持各种数据的实时采集,包括容器文件、容器Stdout、宿主文件、Journal、Event等;支持多种采集部署方式,包括DaemonSet、Sidecar、DockerEngine LogDriver等;日志数据丰富,包括Namespace、Pod、Container、Image、Node等附加信息;稳定高可靠,基于阿里巴巴自研Logtail采集Agent实现。目前,全网部署实例数以百万计。; 基于CRD扩展,日志采集规则可以以Kubernetes部署发布的方式部署,与CICD完美集成。

安装日志采集组件

目前,这个采集解决方案已经对外开放。我们提供 Helm 安装包,收录 Logtail 的 DaemonSet、AliyunlogConfig 的 CRD 声明和 CRD Controller。安装后直接使用DaemonS优采云采集器即可,CRD配置完毕。安装方法如下:

阿里云Kubernetes集群在激活的时候就可以安装,这样在创建集群的时候会自动安装以上的组件。如果激活的时候没有安装,可以手动安装。如果是自建Kubernetes,无论是自建在阿里云上还是在其他云上还是离线,都可以使用这个采集方案。具体安装方法请参考【自建Kubernetes安装】()。

上述组件安装完成后,Logtail和对应的Controller会在集群中运行,但默认这些组件不会采集任何日志,需要配置日志采集规则为采集@ > 指定各种日志的Pod。

采集规则配置:环境变量或CRD

除了在日志服务控制台手动配置外,Kubernetes 还支持另外两种配置方式:环境变量和 CRD。

环境变量是自swarm时代以来一直使用的配置方式。你只需要在你想要采集的容器环境变量上声明需要采集的数据地址,Logtail会自动采集这个数据>到服务器。该方法部署简单,学习成本低,易于使用;但是可以支持的配置规则很少,很多高级配置(如解析方式、过滤方式、黑白名单等)都不支持,而且这种声明方式也不支持修改/删除,每个修改实际上创建了一个新的 采集 配置。历史采集配置需要手动清理,否则会造成资源浪费。

CRD的配置方式非常符合Kubernetes官方推荐的标准扩展方式,允许采集配置以K8s资源的形式进行管理,通过部署特殊的CRD资源AliyunLogConfig到Kubernetes来声明数据这需要 采集。例如,下面的例子是部署一个容器的标准输出采集,其中定义需要Stdout和Stderr 采集,并且排除环境变量收录COLLEXT_STDOUT_FLAG: false的容器。基于CRD的配置方式以Kubernetes标准扩展资源的方式进行管理,支持配置的完整语义的增删改查,支持各种高级配置。

采集推荐的规则配置方式

在实际应用场景中,一般使用 DaemonSet 或者 DaemonSet 和 Sidecar 的混合。DaemonSet 的优点是资源利用率高。但是存在一个问题,DaemonSet的所有Logtail共享全局配置,单个Logtail有配置支持上限。因此,它无法支持具有大量应用程序的集群。以上是我们给出的推荐配置方式。核心思想是:

一个尽可能多的采集相似数据的配置,减少了配置的数量,减轻了DaemonSet的压力;核心应用 采集 需要获得足够的资源,并且可以使用 Sidecar 方法;配置方式尽量使用CRD方式;Sidecar 由于每个Logtail都是独立配置的,所以配置数量没有限制,适用于非常大的集群。

练习 1 - 中小型集群

大多数 Kubernetes 集群都是中小型的。中小企业没有明确的定义。一般应用数量小于500,节点规模小于1000。没有功能清晰的Kubernetes平台运维。这个场景的应用数量不是特别多,DaemonSet可以支持所有的采集配置:

大部分业务应用的数据使用DaemonS优采云采集器方式,核心应用(对于可靠性要求较高的采集,如订单/交易系统)单独使用Sidecar方式采集 @>

练习 2 - 大型集群

对于一些用作PAAS平台的大型/超大型集群,一般业务在1000以上,节点规模也在1000以上。有专门的Kubernetes平台运维人员。这种场景下应用的数量没有限制,DaemonSet 无法支持。因此,必须使用 Sidecar 方法。总体规划如下:

Kubernetes平台的系统组件日志和内核日志的类型是比较固定的。这部分日志使用了DaemonS优采云采集器,主要为平台的运维人员提供服务;每个业务的日志使用Sidecar方式采集,每个业务可以独立设置Sidecar的采集目的地址,为业务的DevOps人员提供了足够的灵活性。

文章采集api(来说获得用户专栏文章的链接信息,此乃神器!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 149 次浏览 • 2022-02-17 05:24

目前还没有官方API支持。或许最有用的就是用户的“个性化URL”(好别扭,以下简称UID),比如黄继新老师的UID:jixin,不过可以用户自己修改,但是每个用户都必须是独特的。

将对应的 UID 替换为 {{%UID}}。

1. 获取用户列条目:

URI: http://www.zhihu.com/people/{{%UID}}/posts GET/HTTP 1.1

XPATH: //div[@id='zh-profile-list-container']

通过解析上述内容,可以得到用户的所有列入口地址。

2. 获取列 文章 信息:

URI: http://zhuanlan.zhihu.com/api/columns/{{%UID}}/posts?limit={{%LIMIT}}&offset={{%OFFSET}} GET/HTTP 1.1

{{%LIMIT}}:表示本次GET请求获取的数据项个数,即文章列信息的个数。我没有具体测试过最大值是多少,但是可以设置大于默认值。默认值为 10。

{{%OFFSET}}:表示本次GET请求获取的数据项的起始偏移量。

通过分析以上内容,可以得到每一列文章的信息,如标题、题图、列文章摘要、发布时间、批准数等。请求返回JSON数据。

注意:解析该信息时,可以得到该列文章的链接信息。

3. 获取列 文章:

URI: http://zhuanlan.zhihu.com/api/columns/{{%UID}}/posts/{{%SLUG}} GET/HTTP 1.1

{{%SLUG}}:是2中得到的文章链接信息,目前是8位数字。

通过分析以上内容,可以得到文章栏的内容,以及文章的一些相关信息。请求返回 JSON 数据。

以上应该足以满足题主的要求。最重要的是用好Chrome调试工具,这是神器!

* * * * * * * * * *

这里有一些零散的更新来记录 知乎 爬虫的想法。当然,相关实现还是需要尊重ROBOTS协议,可以通过

/机器人.txt

检查相关参数。

UID是用户所有信息的入口。

虽然用户信息有修改间隔限制(一般为几个月不等),但考虑到即使是修改用户名的操作也会导致UID发生变化,从而使之前的存储失效。当然,这也可以破解:用户哈希。这个哈希值是一个 32 位的字符串,对于每个账户来说都是唯一且不变的。

通过 UID 获取哈希:

URI: http://www.zhihu.com/people/%{{UID}} GET/HTTP 1.1

XPATH: //body/div[@class='zg-wrap zu-main']//div[@class='zm-profile-header-op-btns clearfix']/button/@data-id

通过解析上面的内容,可以得到UID对应的hash值。(是的,该值存储在“关注/取消关注”按钮中。)这唯一地标识了用户。

目前没有办法通过hash_id获取UID,但是有间接方法可以参考:定期通过关注列表查看用户信息是否发生变化,当然关注/取消关注操作也可以自动化:

关注操作

URI: http://www.zhihu.com/node/MemberFollowBaseV2 POST/HTTP 1.1

Form Data

method: follow_member

params: {"hash_id": "xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx"}

_xsrf:

取消关注操作

URI: http://www.zhihu.com/node/MemberFollowBaseV2 POST/HTTP 1.1

Form Data

method: unfollow_member

params: {"hash_id": "xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx"}

_xsrf:

知乎爬虫需要一个UID列表才能正常运行,如何获取这个列表是需要考虑的问题。目前一个可行的思路是选择几个大V用户,批量爬取他们的关注列表。比如张老师目前跟随着58W+,通过:

URI: http://www.zhihu.com/node/ProfileFollowersListV2 POST/HTTP 1.1

Form Data

method: next

params: {"offset": {{%OFFSET}}, "order_by": "hash_id", "hash_id": "{{%HASHID}}"}

_xsrf:

每次可以获得20个关注者的用户信息。此信息包括 hash_id、用户名、UID、关注者/关注者数量、问题数量、答案数量等。 查看全部

文章采集api(来说获得用户专栏文章的链接信息,此乃神器!)

目前还没有官方API支持。或许最有用的就是用户的“个性化URL”(好别扭,以下简称UID),比如黄继新老师的UID:jixin,不过可以用户自己修改,但是每个用户都必须是独特的。

将对应的 UID 替换为 {{%UID}}。

1. 获取用户列条目:

URI: http://www.zhihu.com/people/{{%UID}}/posts GET/HTTP 1.1

XPATH: //div[@id='zh-profile-list-container']

通过解析上述内容,可以得到用户的所有列入口地址。

2. 获取列 文章 信息:

URI: http://zhuanlan.zhihu.com/api/columns/{{%UID}}/posts?limit={{%LIMIT}}&offset={{%OFFSET}} GET/HTTP 1.1

{{%LIMIT}}:表示本次GET请求获取的数据项个数,即文章列信息的个数。我没有具体测试过最大值是多少,但是可以设置大于默认值。默认值为 10。

{{%OFFSET}}:表示本次GET请求获取的数据项的起始偏移量。

通过分析以上内容,可以得到每一列文章的信息,如标题、题图、列文章摘要、发布时间、批准数等。请求返回JSON数据。

注意:解析该信息时,可以得到该列文章的链接信息。

3. 获取列 文章:

URI: http://zhuanlan.zhihu.com/api/columns/{{%UID}}/posts/{{%SLUG}} GET/HTTP 1.1

{{%SLUG}}:是2中得到的文章链接信息,目前是8位数字。

通过分析以上内容,可以得到文章栏的内容,以及文章的一些相关信息。请求返回 JSON 数据。

以上应该足以满足题主的要求。最重要的是用好Chrome调试工具,这是神器!

* * * * * * * * * *

这里有一些零散的更新来记录 知乎 爬虫的想法。当然,相关实现还是需要尊重ROBOTS协议,可以通过

/机器人.txt

检查相关参数。

UID是用户所有信息的入口。

虽然用户信息有修改间隔限制(一般为几个月不等),但考虑到即使是修改用户名的操作也会导致UID发生变化,从而使之前的存储失效。当然,这也可以破解:用户哈希。这个哈希值是一个 32 位的字符串,对于每个账户来说都是唯一且不变的。

通过 UID 获取哈希:

URI: http://www.zhihu.com/people/%{{UID}} GET/HTTP 1.1

XPATH: //body/div[@class='zg-wrap zu-main']//div[@class='zm-profile-header-op-btns clearfix']/button/@data-id

通过解析上面的内容,可以得到UID对应的hash值。(是的,该值存储在“关注/取消关注”按钮中。)这唯一地标识了用户。

目前没有办法通过hash_id获取UID,但是有间接方法可以参考:定期通过关注列表查看用户信息是否发生变化,当然关注/取消关注操作也可以自动化:

关注操作

URI: http://www.zhihu.com/node/MemberFollowBaseV2 POST/HTTP 1.1

Form Data

method: follow_member

params: {"hash_id": "xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx"}

_xsrf:

取消关注操作

URI: http://www.zhihu.com/node/MemberFollowBaseV2 POST/HTTP 1.1

Form Data

method: unfollow_member

params: {"hash_id": "xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx"}

_xsrf:

知乎爬虫需要一个UID列表才能正常运行,如何获取这个列表是需要考虑的问题。目前一个可行的思路是选择几个大V用户,批量爬取他们的关注列表。比如张老师目前跟随着58W+,通过:

URI: http://www.zhihu.com/node/ProfileFollowersListV2 POST/HTTP 1.1

Form Data

method: next

params: {"offset": {{%OFFSET}}, "order_by": "hash_id", "hash_id": "{{%HASHID}}"}

_xsrf:

每次可以获得20个关注者的用户信息。此信息包括 hash_id、用户名、UID、关注者/关注者数量、问题数量、答案数量等。

文章采集api(什么是zhihu-articles-api(.json)。。)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2022-02-16 14:20

简介:知乎-articles-api

将您的 知乎文章 导出为可用的 API (.json)。

什么是知乎文章API?

知乎-articles-api 是一个基于 JavaScript DOM 的脚本,通过 DOM 将你的 知乎文章 导出为 json 格式的 API 文档,其中收录标题、链接、标题图等信息。这些 API 可用于其他网站或您自己来显示您创建的内容。当用户访问这些内容时,用户会跳转到知乎,从而批准和评论您的内容。

如何使用知乎文章API?

与其他 JavaScript 脚本一样,您需要使用浏览器的调试功能来执行这些脚本。

首先,您需要访问您的个人主页。

知乎的个人主页一般是:

您的个人域名

如果您不知道自己的个人域名,可以从首页右上角的头像访问“我的首页”。

切换到“文章”选项卡

zaa 只能在该选项卡下工作。

如果您希望导出其他内容,请务必仔细阅读源代码并修改相关内容。

在这个选项卡下,通过调试脚本的执行,浏览器会自动下载一个名为username.json的文件。

脚本:

例子:

{

"Article_0": {

"headline": "为K100 Pro更换更大容量的电池",

"url": "zhuanlan.zhihu.com/p/205607070",

"dateP": "2020-08-29T14:22:15.000Z",

"dateM": "2020-09-01T17:17:49.000Z",

"img": "https://pic4.zhimg.com/v2-8ac0 ... ot%3B

},

"Article_1": {

"headline": "ES6动态计算属性名的另外一种用法/属性名表达式",

"url": "zhuanlan.zhihu.com/p/199698763",

"dateP": "2020-08-26T15:24:06.000Z",

"dateM": "2020-08-27T02:42:41.000Z",

"img": "https://pic4.zhimg.com/v2-8ac0 ... ot%3B

},

"Article_2": {

"headline": "为Vuetify的UI组件添加滚动条",

"url": "zhuanlan.zhihu.com/p/196736891",

"dateP": "2020-08-24T10:25:53.000Z",

"dateM": "2020-08-24T10:25:53.000Z",

"img": "https://pic4.zhimg.com/v2-8ac0 ... ot%3B

},

"Article_3": {

"headline": "解决移动端左右滑动/溢出问题",

"url": "zhuanlan.zhihu.com/p/194403402",

"dateP": "2020-08-22T16:20:05.000Z",

"dateM": "2020-08-22T16:20:05.000Z",

"img": "https://pic4.zhimg.com/v2-8ac0 ... ot%3B

},

知乎-articles-api 合法吗?

与所有爬虫、API 等一样,请确保您在相关用户协议的规范范围内使用您获取的内容。

由于 知乎-articles-api 在 DOM 上运行,获取的内容是公开可用的,并且已经加载到用户端,我认为这不会导致非法行为。

但是,请不要将本脚本用于非您创作的内容,也不要将本脚本获得的内容用于商业目的,本人对本脚本的任何使用概不负责。

我还是不明白这个脚本是做什么的

对于托管在 Github 上的静态页面,如何动态生成博文是一个非常棘手的问题。如果使用普通的静态页面生成器(markdown),虽然可行,但还是不方便更新维护。个人网站的流量往往比较少,不利于创意内容的传播。

通过知乎-articles-api,将你的文章转换成API,生成json文件。将此文件部署到对象存储并进行 CDN 分发。根据这个json文件生成文章的列表,可以实现创作内容的迁移。只要在云端修改json文件,就可以动态修改静态页面的内容,无需重新生成静态页面。

简单来说,你将自己创建的内容托管在知乎上,相关的静态资源也托管在知乎的服务器上。

已知问题和版本更新:

版本 1.00:

如果你的标题图片是.png格式的透明文件,知乎可能会在服务器上生成两个文件,白色背景和源文件。通过知乎-articles-api生成json文件时,只能访问前者。如果您的网站使用深色主题或夜间模式,则可能值得考虑将 知乎 源文件替换为其他来源的 .png 文件。

感激:

将对象导出为 JSON:

根据自定义属性获取元素(原文已过期,这是转载链接): 查看全部

文章采集api(什么是zhihu-articles-api(.json)。。)

简介:知乎-articles-api

将您的 知乎文章 导出为可用的 API (.json)。

什么是知乎文章API?

知乎-articles-api 是一个基于 JavaScript DOM 的脚本,通过 DOM 将你的 知乎文章 导出为 json 格式的 API 文档,其中收录标题、链接、标题图等信息。这些 API 可用于其他网站或您自己来显示您创建的内容。当用户访问这些内容时,用户会跳转到知乎,从而批准和评论您的内容。

如何使用知乎文章API?

与其他 JavaScript 脚本一样,您需要使用浏览器的调试功能来执行这些脚本。

首先,您需要访问您的个人主页。

知乎的个人主页一般是:

您的个人域名

如果您不知道自己的个人域名,可以从首页右上角的头像访问“我的首页”。

切换到“文章”选项卡

zaa 只能在该选项卡下工作。

如果您希望导出其他内容,请务必仔细阅读源代码并修改相关内容。

在这个选项卡下,通过调试脚本的执行,浏览器会自动下载一个名为username.json的文件。

脚本:

例子:

{

"Article_0": {

"headline": "为K100 Pro更换更大容量的电池",

"url": "zhuanlan.zhihu.com/p/205607070",

"dateP": "2020-08-29T14:22:15.000Z",

"dateM": "2020-09-01T17:17:49.000Z",

"img": "https://pic4.zhimg.com/v2-8ac0 ... ot%3B

},

"Article_1": {

"headline": "ES6动态计算属性名的另外一种用法/属性名表达式",

"url": "zhuanlan.zhihu.com/p/199698763",

"dateP": "2020-08-26T15:24:06.000Z",