文章采集完

《》能够帮助用户迅速执行文章信息采集操作的方法

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-08-24 23:08

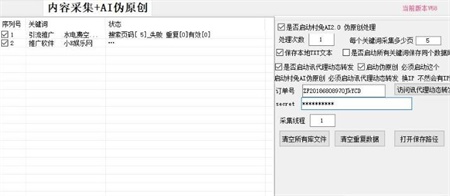

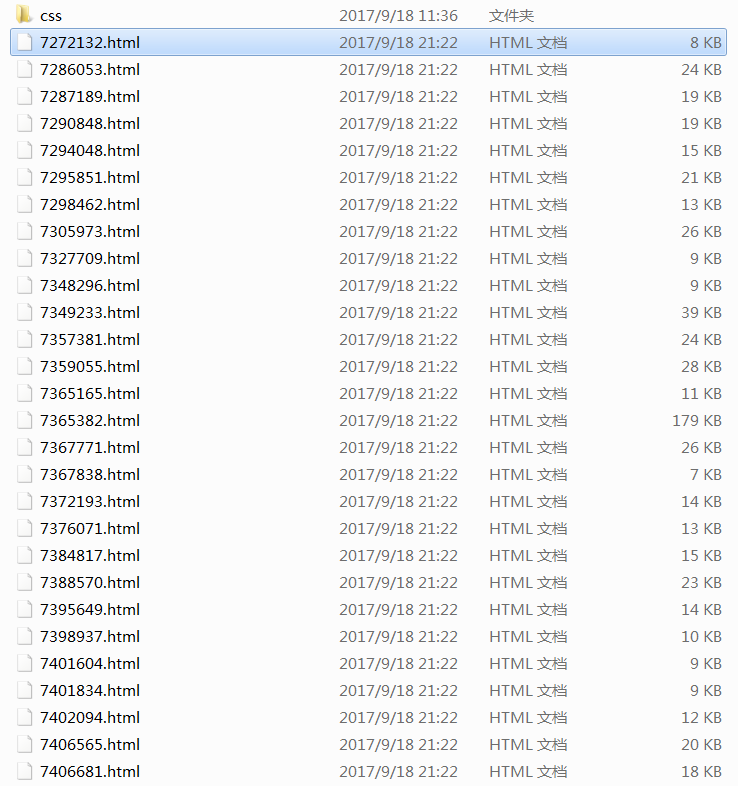

“AI Smart文章采集software”可以帮助用户快速进行文章信息采集操作,其强大的功能不仅可以进行采集,还可以帮助用户进行伪原创处理,用户只需要导入需要采集文章的关键词,本软件可以帮助用户轻松完成相关的文章content采集操作。

AI Intelligence文章采集软件功能

1、智慧采集

用户只需输入自己想要的采集文章关键词,即可轻松实现文章采集的功能。本软件会尽快帮助采集文章用户@Information。

2、伪原创function

是的,这个强大的工具不仅仅是采集play。用户也可以根据自己的需要对文章进行伪原创处理。使用起来非常方便实用。

3、改进收录

本软件可以帮助用户处理采集好文章伪原创,大大增加了收录网站的处理量,同时也允许用户将文章保存到本地的txt格式文件中。

4、许多功能

支持用户通过本软件进行一键发布功能。无论用户是想做自媒体还是发送软文,都可以通过这个实用工具轻松完成工作需求。

AI Intelligence文章采集Software 软件亮点

1、营销推广

完美借鉴其他作者的文章,进行高水平的伪原创处理工作,帮助用户提升营销效果,为用户带来全新不一样的交互体验。

2、增强转化

有效提升用户原创度,让用户文章快速提升在网站中的排名,获得更多流量转化,为用户带来超强的网站流量收益效果。

3、采集面广

无论是今日头条、趣头条,还是小道消息,网站的文章都可以通过这个神器采集联系到,轻松解决用户日常写作的素材问题,非常容易使用。

4、点击使用

如果用户点击启动软件,软件会自动启动采集文章内容。如果用户点击暂停,软件也会自动执行暂停功能,操作简单方便。

AI Smart文章采集software 软件说明

1、这个实用工具可以帮助用户快速提升他们在网站、收录率、转化数据中的文章排名,让用户得到最舒服的收益效果。

2、文章采集一个充分为用户考虑的工具,可以帮助用户去各大资讯网站采集爆款文章,让用户轻松掌握第一手资料.

3、即点即用的操作方式让用户可以轻松享受该实用程序的便利。点击即可使用,点击关闭即可。操作方法非常简单方便。

AI Smart文章采集软件安装步骤

1、 下载完成后,用户可以打开下载的安装包。

2、 进入安装流程后,用户需要阅读用户安装协议。

3、 用户阅读协议后即可开始自定义安装路径。

4、选择安装路径后,用户即可开始安装,安装完成即可使用。

AI Smart文章采集软件功能描述

1、智慧伪原创

利用人工智能中的自然语言处理技术实现文章伪原创处理。核心功能包括“smart伪原创”、“同义词替换伪原创”、“反义词替换伪原创”、“用html代码在文章中随机插入关键词”、“句子打乱重组”等等等,处理后的文章原创度和收录率都在80%以上。想了解更多功能,请下载软件试用。

2、Portal文章采集

一键搜索采集相关门户网站新闻文章、网站有搜狐、腾讯、新浪、网易、今日头条、新兰网、联合早报、光明.com、站长.com、新文化类网站,用户可以输入行业关键词搜索想要的行业文章。该模块的特点是无需编写采集规则,一键操作。友情提示:文章使用时请注明文章出处,尊重原文版权。

3、百度新闻采集

一键搜索各界新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需写任何采集规则,但缺点是采集的文章不必须是完整的,但是可以满足大部分用户的需求。友情提示:文章使用时请注明文章出处,尊重原文版权。 查看全部

《》能够帮助用户迅速执行文章信息采集操作的方法

“AI Smart文章采集software”可以帮助用户快速进行文章信息采集操作,其强大的功能不仅可以进行采集,还可以帮助用户进行伪原创处理,用户只需要导入需要采集文章的关键词,本软件可以帮助用户轻松完成相关的文章content采集操作。

AI Intelligence文章采集软件功能

1、智慧采集

用户只需输入自己想要的采集文章关键词,即可轻松实现文章采集的功能。本软件会尽快帮助采集文章用户@Information。

2、伪原创function

是的,这个强大的工具不仅仅是采集play。用户也可以根据自己的需要对文章进行伪原创处理。使用起来非常方便实用。

3、改进收录

本软件可以帮助用户处理采集好文章伪原创,大大增加了收录网站的处理量,同时也允许用户将文章保存到本地的txt格式文件中。

4、许多功能

支持用户通过本软件进行一键发布功能。无论用户是想做自媒体还是发送软文,都可以通过这个实用工具轻松完成工作需求。

AI Intelligence文章采集Software 软件亮点

1、营销推广

完美借鉴其他作者的文章,进行高水平的伪原创处理工作,帮助用户提升营销效果,为用户带来全新不一样的交互体验。

2、增强转化

有效提升用户原创度,让用户文章快速提升在网站中的排名,获得更多流量转化,为用户带来超强的网站流量收益效果。

3、采集面广

无论是今日头条、趣头条,还是小道消息,网站的文章都可以通过这个神器采集联系到,轻松解决用户日常写作的素材问题,非常容易使用。

4、点击使用

如果用户点击启动软件,软件会自动启动采集文章内容。如果用户点击暂停,软件也会自动执行暂停功能,操作简单方便。

AI Smart文章采集software 软件说明

1、这个实用工具可以帮助用户快速提升他们在网站、收录率、转化数据中的文章排名,让用户得到最舒服的收益效果。

2、文章采集一个充分为用户考虑的工具,可以帮助用户去各大资讯网站采集爆款文章,让用户轻松掌握第一手资料.

3、即点即用的操作方式让用户可以轻松享受该实用程序的便利。点击即可使用,点击关闭即可。操作方法非常简单方便。

AI Smart文章采集软件安装步骤

1、 下载完成后,用户可以打开下载的安装包。

2、 进入安装流程后,用户需要阅读用户安装协议。

3、 用户阅读协议后即可开始自定义安装路径。

4、选择安装路径后,用户即可开始安装,安装完成即可使用。

AI Smart文章采集软件功能描述

1、智慧伪原创

利用人工智能中的自然语言处理技术实现文章伪原创处理。核心功能包括“smart伪原创”、“同义词替换伪原创”、“反义词替换伪原创”、“用html代码在文章中随机插入关键词”、“句子打乱重组”等等等,处理后的文章原创度和收录率都在80%以上。想了解更多功能,请下载软件试用。

2、Portal文章采集

一键搜索采集相关门户网站新闻文章、网站有搜狐、腾讯、新浪、网易、今日头条、新兰网、联合早报、光明.com、站长.com、新文化类网站,用户可以输入行业关键词搜索想要的行业文章。该模块的特点是无需编写采集规则,一键操作。友情提示:文章使用时请注明文章出处,尊重原文版权。

3、百度新闻采集

一键搜索各界新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需写任何采集规则,但缺点是采集的文章不必须是完整的,但是可以满足大部分用户的需求。友情提示:文章使用时请注明文章出处,尊重原文版权。

优采云资讯采集规则分组和优采云软件的底部留有链接教程

采集交流 • 优采云 发表了文章 • 0 个评论 • 172 次浏览 • 2021-08-24 23:05

大家好,继续昨天没有完成的资料采集教程。如果你是直接来的,请阅读教程的前半部分并点击查看,以便你理解这部分的内容。昨天我们配置了文章今天配置文章资讯的采集规则的发布模块,文章底部留链接采集Rules和优采云可以自行下载软件。为什么我们需要在网站上添加信息文章?这是与网站SEO收录 相关的关键问题。如果某影视网站能持续更新,文章资讯会给你的网站收录多多加分以获得好排名。好的,让我们开始今天的教程。

一、导入信息采集rule分组,今天不讲优采云软件怎么用。上篇教程请直接跳转:点击查看,我们将直接跳转至优采云software。

①打开优采云software鼠标,在左边空白处右击导入组。组实际上是一个文件夹。文件夹中的每条规则都是一个任务,我们发送给你的规则是一个文件,文件夹中有一条采集规则,所以我们这里选择导入组。 (即导入文件夹)

②图中的文件是采集规则信息的分组文件,我们直接选择这个文件导入。

③导入后,我们开始在storage中配置这条规则,双击图中箭头所指的规则进入编辑页面。

其次,配置信息采集规则。其实我们配置仓库信息采集规则的地方有3个。把这三个地方填好就搞定了。

1.到达编辑页面后,填写对接系统后端的存储验证密码。验证密码的获取方法请参见上半部分的教程。点击查看操作步骤如下图

图片①直接点击第二步“采集content rule”编辑页面

图②双击验证码,弹出图3验证码填写页面

图③在系统后台填写入库验证密码

图④全部填写完毕后,直接点击确定

2.在下拉编辑框中填写类别编号。类别号也在系统后台。如果看不懂,需要阅读上半部分的教程,点击查看

图①双击类别编号,弹出右侧编辑框。

图片②填写你要存放的分类的分类号,不要按我复制。您必须确认自己的分类号才能填写。

图③填写完毕,点击确定。

3、填写分类名称,这个步骤和上一个分类号一样

图①双击类别名称。

图片②填写类别名称。不要复制和确认您要存储的类别。

图③填写完成后点击确定保存

三、点击切换到第三步“发布内容设置”页面导入我们昨天配置的发布模块,导入后点击确定。

四、①三个框都打勾 ②点击开始等待优采云Auto采集内容到达你的网站。 采集本教程到此结束。采集并关注我们。后续我们会持续更新实用教程。

您也可以加入我们的交流群。点击加入。沟通

[站长交流群-650404498]

[百度收录]

[优采云rule 文件下载]

模板推荐:【最新首涂带背景多功能Applecmsv10模板下载】【查看演示】 查看全部

优采云资讯采集规则分组和优采云软件的底部留有链接教程

大家好,继续昨天没有完成的资料采集教程。如果你是直接来的,请阅读教程的前半部分并点击查看,以便你理解这部分的内容。昨天我们配置了文章今天配置文章资讯的采集规则的发布模块,文章底部留链接采集Rules和优采云可以自行下载软件。为什么我们需要在网站上添加信息文章?这是与网站SEO收录 相关的关键问题。如果某影视网站能持续更新,文章资讯会给你的网站收录多多加分以获得好排名。好的,让我们开始今天的教程。

一、导入信息采集rule分组,今天不讲优采云软件怎么用。上篇教程请直接跳转:点击查看,我们将直接跳转至优采云software。

①打开优采云software鼠标,在左边空白处右击导入组。组实际上是一个文件夹。文件夹中的每条规则都是一个任务,我们发送给你的规则是一个文件,文件夹中有一条采集规则,所以我们这里选择导入组。 (即导入文件夹)

②图中的文件是采集规则信息的分组文件,我们直接选择这个文件导入。

③导入后,我们开始在storage中配置这条规则,双击图中箭头所指的规则进入编辑页面。

其次,配置信息采集规则。其实我们配置仓库信息采集规则的地方有3个。把这三个地方填好就搞定了。

1.到达编辑页面后,填写对接系统后端的存储验证密码。验证密码的获取方法请参见上半部分的教程。点击查看操作步骤如下图

图片①直接点击第二步“采集content rule”编辑页面

图②双击验证码,弹出图3验证码填写页面

图③在系统后台填写入库验证密码

图④全部填写完毕后,直接点击确定

2.在下拉编辑框中填写类别编号。类别号也在系统后台。如果看不懂,需要阅读上半部分的教程,点击查看

图①双击类别编号,弹出右侧编辑框。

图片②填写你要存放的分类的分类号,不要按我复制。您必须确认自己的分类号才能填写。

图③填写完毕,点击确定。

3、填写分类名称,这个步骤和上一个分类号一样

图①双击类别名称。

图片②填写类别名称。不要复制和确认您要存储的类别。

图③填写完成后点击确定保存

三、点击切换到第三步“发布内容设置”页面导入我们昨天配置的发布模块,导入后点击确定。

四、①三个框都打勾 ②点击开始等待优采云Auto采集内容到达你的网站。 采集本教程到此结束。采集并关注我们。后续我们会持续更新实用教程。

您也可以加入我们的交流群。点击加入。沟通

[站长交流群-650404498]

[百度收录]

[优采云rule 文件下载]

模板推荐:【最新首涂带背景多功能Applecmsv10模板下载】【查看演示】

图2-9当所需的设置页面中如图(2)

采集交流 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-08-24 05:37

首先,结束标签是:page。填写完毕后可以点击查看链接是否正常。如果不正常,请检查标签设置是否合适,网络是否畅通。图2-9 填写好需要的设置后,点击,列表页面的配置项就设置好了。内容页显示在第三步内容页设置页(2-10),主要是对采集器所需信息的方向如图2-10采集的文章内容,和这个方向是一样的 是在这个页面的源代码中通过特定的标记设置的,具体设置如下: 【标题提取方法】:这里有两个选项,自动提取和采集在页面上,选择“自动提取”时,系统将在文章的内容页面中自动删除文章标题采集。当您选择“从页面采集”时,文章标题你被采集锁定的会自动弹出,有两个填写框,分别是“Title Start Mark”和“Title End Mark”,如图(2-11).图2-11) Title Start Mark”和“Title End Mark”可以通过匹配来捕获 取文章的标题,一般用于标题开始标签和标题结束标签,填写后点击预览标记的标题e. 【文本提取方法】:这里也有两个选项,自动提取和从页面采集,当您选择“自动提取”时,系统会自动在文章内容中删除文章内容采集页。当您选择“来自页面的采集”时,您将被采集你锁定的文章内容。选择后会自动弹出两个填写框,分别是“Body Start Mark”和“Body End Mark”,如图(2-12).

图2-12“Body start tag”和“Body end tag”可以用来捕获文章的body。注意这里的标签必须能够唯一标识文章内容。填写完毕后,可以点击预览。 【采集text 格式】:这里有两个选项,分别是:纯文本和超文本。选择纯文本时,采集中的文章内容会以纯文本格式保存;选择超文本时,文章 Content来自采集将以超文本格式保存。 【过滤标签】:这里采集网页常用的标签。当采集不需要某个标签的效果时,可以在此处选择该标签,当采集时,会将选中的标签过滤掉。 【下一页内容】:这里有两个选项。当文章content页面没有下一页时,选择not采集分页,当文章content页面中有页面时,选择获取下一页或下一页的链接标签。这里的标签设置与板块列表页【列表下一页:】设置项“获取下一页”中标签的设置方法相同。如图(2-13)图2-13) 设置该页面的设置项后,点击,设置文章content的采集。附在第四步的附加设置页面,如图(2-14),主要是设置一些图片、附件以及一些用户想要采集在一些网页中的附加内容。这里的设置是可选的,如果用户有需要,可以设置,否则不需要设置,采用默认状态,接下来我们单独介绍页面上的设置项。

图2-14【任务名称】:显示这个采集任务的名称。 【发布状态】:这里有两个选项:“采集审核后发布”和“采集立即发布”。当信息采集需要对来自采集的文章进行审核,并且审核通过后才能发布(前提是网站中已经存在文章审核流),可以选择“采集需要审核后才能发布”,当信息采集器不需要审核文章采集并发布时,可以选择“采集后立即发布” 》。【内容内嵌图片】:一般情况下,网页上的文章内容都会嵌入一些图片来美化页面。文章采集器也希望采集system可以采集文章内容同时,内容中的图片也是采集下的,针对信息采集的需求,我们专门为此开发了这个功能,我们在这里为信息设置了两个选项采集器选择,当信息采集器考虑本地磁盘空间,不想把采集页面中的图片下载到本地,只想链接t图片、信息采集可以选择默认的“不要下载,链接到原地址(推荐)”选项。当信息采集器想将采集页面中的图片下载到本地时,使用方便,可以选择“下载并存储到本地系统”选项。 【设置图片链接】:如果你想使用文章内容页面中采集的图片作为这个文章的链接,那么你可以在这里设置。在本设置项中选择提取内容中的图片作为图片链接;如果不需要,可以选择不设置图片链接。

【附件】:这里有两个选项:“不要下载”和“下载并存储在本地系统”。除了展示的内容,部分文章还有附件供读者阅读。当采集器采集文章时,如果要删除附件采集,可以在此处选择“下载并存储在本地系统”。这时候下面会自动出现一个填充目标附件位置的标签条目,如图(2-15).然后填写可以用来定位附件的开始标记和结束标记在出现的两个字段中,点击。右边可以预览你想要的采集的附件信息,当采集器只需要采集文章的内容,而你不想要的时候图2-15【作者姓名获取方式】:当文章采集要在采集下方的文章内容中添加作者姓名时,您可以选择“不下载”。可以选择“指定作者姓名”,然后在下方【指定作者姓名为】右侧的输入框中填写要起草的作者姓名。当文章采集器想直接获取时原文章内容中的作者姓名,可以选择“采集 from the page”,下面会自动出现一个标签条目,填写目标作者的位置,如sho wn 在图 (2-16).图 2-16。然后在出现的两个条目中填写可用于定位作者位置的开始和结束标签。单击。右侧可以预览你想要的采集的作者信息。:【信息获取方式】:一般文章会标识其内容的来源。我们这里也特意添加了采集数据源功能,方便文章采集器获取源信息。

有时候采集people想在采集往下的文章内容中添加自己设置的数据源信息时,可以选择“指定源名称”,然后点击【指定数据源名称】 ] 下面为] 在右侧的输入框中填写要设置的数据源的信息。当文章采集想直接获取原创的文章内容数据源信息时,可以选择“采集source from the page”,会自动出现一个标签填写目标数据源的位置下面。项,如图(2-17)。然后在出现的两个字段中填写可以定位数据源位置的开始标记和结束标记。点击右侧预览文章数据采集的图2-17【获取摘要的方法】:一般文章会附带一些内容摘要,为文章提供内容摘要,这里我们也特意添加了采集摘要的功能。当文章当采集器想直接从文章内容开头截取一部分内容作为这个文章内容的摘要,选择从正文截取摘要,然后输入你想要的想在下方【获取正文】右侧的输入框中截取文章开头的内容中的字符数,有时候如果文章采集想直接获取原来的文章内容摘要信息,他们可以从页面中选择采集摘要,然后它会自动出现在下面的标签填写项为loca出现目标内容摘要,如图(2-18).图2-18 然后在出现的两个填写位置中填写可用于定位内容摘要位置的开始标签和结束标签。点击右侧可以预览你想要的信息采集文章内容摘要。

如果采集的文章中没有配置摘要,可以选择不采集。当所有必填的设置项都填好后,点击,本页填写的信息就设置成功了。以上四步都设置好后,一个完整的文章list内容页文章采集任务就设置好了。 RSS文章List采集Task Settings RSS 是站点与其他站点共享内容(也称为聚合内容)的一种简单方式,通常用于文章 和其他网站的顺序@。 RSS已成为目前最成功的XML应用,为信息的快速传播搭建了技术平台,让每个人都成为潜在的信息提供者。目前很多大型的网站都提供了RSS支持。基于这种情况,我们还专门开发了自动采集RSS文章功能。接下来,我们将详细介绍如何采集RSS文章。 RSS文章采集也与文章表页文章的采集相同。首先创建一个采集任务,通过(图2-3).现在)中的四个步骤分别介绍。 【第一步:基础】:本任务的基础设置页面和采集文章表页文章的设置页面为一页,如图(2-3).提供的设置大部分相同,唯一不同的是:在“采集List Type”项中选择RSS链接,在“采集List Address”中需要填写@的RSS格式的XML链接地址采集文章,例如新浪RSS频道文章中心下的文章要闻列表(HYPERLINK "/news/marquee/ddt.xml" /news/marquee/ddt.xml),功能和设置以及其他项目采集文章list 页面的选项相同。

这里不多介绍。 【步骤二:列表页面】:该页面的设置项主要包括内容去重的设置和填写RSS文章content页面的链接地址。内容页链接的设置是为下一步采集具体文章内容做准备,如图(2-19)。具体操作是在RSS文章中打开一个文章 @list page and put this 在这里的内容链接地址栏中填写文章content页面的地址,然后点击预览即可,这个设置的原因和文章content显示的原因是一样的普通文章列表的页面,使用相同的内容展示页面,这里需要注意的是此项必须填写。 图2-19【步骤3:内容页面】:该页面的设置功能是采集文章的列表页中的第三个步骤内容页设置的功能是一样的,如图(2-20)。具体操作也一样,就不介绍了图2-20【步骤4:附加】:该页面的样式如图(2-21) 图2-21 该页面设置的功能和操作方法同上) 采集文章 列表页面。通过以上步骤设置后,一个完整的RSS文章采集任务就完成了,接下来就可以采集RSS文章了。 2.1.3 修改任务 当信息采集器想修改已经创建的任务中的设置信息时,只需点击要更改的任务名称,在任务设置界面进行更改弹出。 2.1.4 删除任务时信息采集器 出于某种原因,采集一个文章在文章的列表中,要删除时可以选择采集任务删除,点击,采集任务将被删除。

2.1.5 启用和禁用任务 为了方便地启用和禁用采集任务,我们特地在任务列表的上半部分添加了这两个功能,如图(2-1).当采集管理者想要启用某些任务时,只需选择要启用的任务,然后点击,该任务被启用;当采集管理者想要停止一些已经启用的任务时, 2.1.6 设置计划 计划主要是为采集tasks 设置定时启动,此功能为采集器提供信息,智能采集方案方便采集器的维护,同时也提高了文章的时效性,具体操作点击弹出如图(2-22)界面,图2 -22,然后在弹出框中详细填写配置项,点击,采集plan添加成功。注意:配置项中的任务名称是指任务n 采集 任务的名称。此项必须正确填写,以确保任务执行正确。 2.1.7 设置模板 在2.1.1 部分,我们提到了设置模板的功能。下面我们来具体介绍一下。当文章管理员需要把某个采集设置为模板以备将来使用时,直接选择采集task,点击采集task右侧操作中的“设置为模板”记录。然后,这个采集task会作为模板保存到【Task Template】列中。 2.1.8 采集记录管理采集记录管理的功能配置在名称旁边每个采集任务方便信息采集器对采集记录被维护。

点击采集任务名称左侧的【查看记录】,进入采集记录管理页面,如图(2-23)。该页面共有三个设置,分别是:重置采集 @status,删除采集status,清除采集status。采集的文章的来源信息记录在下面的列表页,这个功能方便采集器查看采集信息下的文章的来源,每条记录都有一个链接,如图2-23 重置采集状态 每个采集任务执行后,所有采集记录都会列在这个页面上。当信息采集zhe发现采集down的一个文章的显示格式或内容不正确或不符合自己的需要时,需要更改任务设置,然后重新采集 @为这条文章,但必填 当没有被其他采集down的文章重新采集时,信息采集可以选择这条记录,点击,这条的采集标记记录将变为“不采集”。接下来采集器可以更改任务的设置,af ter更改,然后采集再次,现在你需要重新采集文章采集down,并将其保存到指定的文章组件如果采集人不想要不满意文章,可以删除文章source 列中原来的文章。删除采集记录,因为系统执行采集任务会记录在采集记录管理中。如果下次执行任务,如果采集记录管理中有采集记录,则跳过这条记录,而不是采集。所以如果@当采集器想要重新采集某条或部分文章记录,你必须在这里删除这些采集记录,然后执行任务,系统会重置文章这些记录采集又下来了。

具体操作是选中要删除的记录,点击,该记录就会被删除。清除采集记录 当采集器想在某个任务中重新采集文章时,则必须在该页面删除该任务中的所有记录。为了方便删除,我们提供了清除采集记录的功能。只要你点击这个页面,所有的记录都会被删除。 2.2 任务控制台 任务控制台主要提供采集任务的启停管理。其控制界面如图(2-24)。蓝色的任务工作区会显示采集任务进程的信息。所有要执行的任务必须在任务控制台中启动。需要说明的是这里是如果信息采集器已经创建了很多采集任务,但是你想指定任务什么时候执行,你必须在任务中把其他没有执行的任务的状态改为禁用状态设置,然后采集。如果要在采集的过程中停止采集,直接点击,采集Task就会被终止。图2-242.3 任务日志这里的功能主要是详细记录采集任务的操作,比如启动一个任务然后执行,这里会记录任务执行过程中发生的操作。如图(2-25):图2) -25 该功能用于采集任务有问题的时候查找和排查问题,当采集管理员不想在这里显示日志时,可以选择日志并单击它。如果管理员想要删除所有日志,点击,此时页面上的所有日志都会被清除。

另外,这里还配置了模糊查询功能。为了方便管理员查询记录。 2.4 任务模板 该模块主要存储2.1.7部分设置的任务模板,同时也记录了任务模板的相关信息,如模板名称、模板描述、采集地址。此外,其模块中还配置了模糊查询功能,方便管理员快速查找。如图(2-26):图2-26 如果管理员不需要某个模板,当您想删除它时,可以选择该模板并点击它。2.5 回收站删除任务信息记录在页面显示如下图,这里可以恢复删除的记录,只需要选中记录,点击按钮,如果确定要完全删除记录,点击记录下图中完全删除操作。 图2-273.HYPERLINK "7:8080/system/reptile/manager.jsp" \o "数据抓取管理" \t "right" 数据抓取管理3.功能说明@1 HYPERLINK "7:8080/system/reptile/manager.jsp" \o "数据采集管理" \t "right" 数据采集管理概述 根据用户的设置方法提取外部数据库中的数据信息并存储在本产品使用的数据库中,数据以文章的形式显示(即任意数据库表中的数据为以用户指定的方式捕获到本产品的文章表中)。

其特点:可以对任意数据库进行操作,可以联合抓取多张表的数据。操作简单,用户自定义任务和数据提取。您可以制定计划,定期、定量地从所需数据库中提取数据,并展示在本产品的前台网站文章页面上。 3.2 任务设置 图3-1 当您需要添加新的数据采集任务时,可以在弹出的页面中点击 添加采集任务。数据抓包的任务设置分为三步(基本信息设置、抓包信息设置、表属性映射设置),填写任务时必须一步一步填写。在每个步骤中,所有带有符号的项目都是必需的。 3.2.1 基本信息设置在第一步建立数据采集任务的基本信息页面。需要填写的项目如图(3-2)。图3-2【任务名称】:这个文章抓取任务的任务名称。当这个任务处于“启用”状态时, 执行抓取任务时,会执行此任务;当任务处于“禁用”状态时,执行抓取任务时会执行此任务。该任务不执行。 [目标列]:在这里你可以选择将捕获的文章放在该列文章源中。文章源列的选择基于用户的需求。选择单击时,将弹出用于选择页面组件的页面,如图所示图中(3-3)。在页面上选择需要的列文章source,然后点击。执行爬取任务后,抓取到的文章直接存储在指定列文章source中。图3-3【数据库连接池】:源数据库和新数据库都需要在系统管理下的数据库链接池中进行配置。

这里的数据库链接池要设置为数据源所在的连接池。 【每次最多抓取】:这里可以选择每次要抓取的文章的数量。 【发布状态】:这里有两个选项:“需要抓取后审核发布”和“抓取后立即发布”。当数据爬虫需要对抓取的文章进行审核,审核通过后可以发布,可以选择“抓取后需要审核后发布”。当数据爬虫审核抓获的文章When 未经审核发布。您可以选择“抓取后立即发布”。设置好需要的项目后,点击 ,进入第二步列表页面的设置。 3.2.2 抓包信息设置在抓包信息设置页面第二步显示(3-4)填一条sql查询语句。图3-4【任务名称】:这里显示的名字是第一步定义的任务名称。【抓取数据的条件设置】:数据爬虫可以根据自己的需要输入上图中的SQL语句,但必须保证SQL的正确性,否则点击Save After即会出现如图(3-5))的提示信息 图3-53.2.3 表属性映射设置在第三步表属性映射设置的设置页面如图图中(3-6) ,主要是数据抓取器设置了title字段、body字段、抓取文本格式、唯一标识字段、作者、数据源、摘要、关键词、Join时间。保存表属性映射设置,以便设置任务。

图3-63.2. 当数据采集器想要重新修改已经创建的任务中的设置信息时,只需点击要更改的任务记录后的任务设置即可。只需在界面中进行更改。 3.2 当数据抓取器由于某种原因不需要抓取文章 列表中的文章 时。如果你想删除它,你可以选择你要删除的抓取任务,点击它,这个抓取任务就被删除了。 3.2.6 开启任务和关闭任务 为了方便开启和关闭抓取任务的操作,我们特地在任务列表的上半部分增加了这两个功能,如图(3- 1).当数据采集管理器想要开启某些任务时,只需选择要开启的任务,然后点击,任务开启;当数据采集管理器想要停止一些已经开启的任务时,选择要禁用的任务,点击即可。3.2.7 设置计划 设置计划主要是为爬取任务的定时设置,该功能为数据爬虫提供智能爬取计划,方便数据抓取同时也提高了文章的时效性,具体操作是点击弹出界面如图3-7)。如图3-7,然后填写配置项在弹出框中点击,爬取计划添加成功3.2.8 Crawl 当数据爬虫想要管理已经创建的任务记录,只需点击任务记录后进入爬取记录管理界面如图(3-8).在此页面上,可以删除和清除记录。注意:这里删除的记录不会影响已经抓到文章source列的记录。

图3-83.3 任务控制台 任务控制台主要提供抓取任务的启动和停止管理。其控制界面如图(3-9)。所有任务要执行,必须在任务控制台中启动。这里需要注意的是,如果信息抓取器已经创建了很多抓取任务,但是想要要执行指定的任务,必须在任务设置中将其他没有执行的任务的状态改为禁用状态,然后进行爬取,如果在爬取过程中想停止爬取,直接点击,爬取任务图3-93.4 任务日志 这里的功能主要是详细记录抓包操作,比如启动一个任务然后执行,这里会记录执行过程中发生的操作如图(3-10):图3-10 这个函数的作用是的,当爬取任务出现问题的时候,方便我们查找问题和排查问题。当爬网管理器不希望在此处显示日志,您可以选择日志并单击它。如果管理员想要删除所有日志,点击所有日志,此时页面上的所有日志都会被清除。此外,这里还配置了模糊查询功能。方便管理人员查询记录。 3.5 回收站如下图 删除的任务信息记录显示在页面上,可以恢复删除的记录,只需选中该记录,点击按钮即可。如果您确定要完全删除一条记录,请点击下图完全删除该记录。 图3-11 查看全部

图2-9当所需的设置页面中如图(2)

首先,结束标签是:page。填写完毕后可以点击查看链接是否正常。如果不正常,请检查标签设置是否合适,网络是否畅通。图2-9 填写好需要的设置后,点击,列表页面的配置项就设置好了。内容页显示在第三步内容页设置页(2-10),主要是对采集器所需信息的方向如图2-10采集的文章内容,和这个方向是一样的 是在这个页面的源代码中通过特定的标记设置的,具体设置如下: 【标题提取方法】:这里有两个选项,自动提取和采集在页面上,选择“自动提取”时,系统将在文章的内容页面中自动删除文章标题采集。当您选择“从页面采集”时,文章标题你被采集锁定的会自动弹出,有两个填写框,分别是“Title Start Mark”和“Title End Mark”,如图(2-11).图2-11) Title Start Mark”和“Title End Mark”可以通过匹配来捕获 取文章的标题,一般用于标题开始标签和标题结束标签,填写后点击预览标记的标题e. 【文本提取方法】:这里也有两个选项,自动提取和从页面采集,当您选择“自动提取”时,系统会自动在文章内容中删除文章内容采集页。当您选择“来自页面的采集”时,您将被采集你锁定的文章内容。选择后会自动弹出两个填写框,分别是“Body Start Mark”和“Body End Mark”,如图(2-12).

图2-12“Body start tag”和“Body end tag”可以用来捕获文章的body。注意这里的标签必须能够唯一标识文章内容。填写完毕后,可以点击预览。 【采集text 格式】:这里有两个选项,分别是:纯文本和超文本。选择纯文本时,采集中的文章内容会以纯文本格式保存;选择超文本时,文章 Content来自采集将以超文本格式保存。 【过滤标签】:这里采集网页常用的标签。当采集不需要某个标签的效果时,可以在此处选择该标签,当采集时,会将选中的标签过滤掉。 【下一页内容】:这里有两个选项。当文章content页面没有下一页时,选择not采集分页,当文章content页面中有页面时,选择获取下一页或下一页的链接标签。这里的标签设置与板块列表页【列表下一页:】设置项“获取下一页”中标签的设置方法相同。如图(2-13)图2-13) 设置该页面的设置项后,点击,设置文章content的采集。附在第四步的附加设置页面,如图(2-14),主要是设置一些图片、附件以及一些用户想要采集在一些网页中的附加内容。这里的设置是可选的,如果用户有需要,可以设置,否则不需要设置,采用默认状态,接下来我们单独介绍页面上的设置项。

图2-14【任务名称】:显示这个采集任务的名称。 【发布状态】:这里有两个选项:“采集审核后发布”和“采集立即发布”。当信息采集需要对来自采集的文章进行审核,并且审核通过后才能发布(前提是网站中已经存在文章审核流),可以选择“采集需要审核后才能发布”,当信息采集器不需要审核文章采集并发布时,可以选择“采集后立即发布” 》。【内容内嵌图片】:一般情况下,网页上的文章内容都会嵌入一些图片来美化页面。文章采集器也希望采集system可以采集文章内容同时,内容中的图片也是采集下的,针对信息采集的需求,我们专门为此开发了这个功能,我们在这里为信息设置了两个选项采集器选择,当信息采集器考虑本地磁盘空间,不想把采集页面中的图片下载到本地,只想链接t图片、信息采集可以选择默认的“不要下载,链接到原地址(推荐)”选项。当信息采集器想将采集页面中的图片下载到本地时,使用方便,可以选择“下载并存储到本地系统”选项。 【设置图片链接】:如果你想使用文章内容页面中采集的图片作为这个文章的链接,那么你可以在这里设置。在本设置项中选择提取内容中的图片作为图片链接;如果不需要,可以选择不设置图片链接。

【附件】:这里有两个选项:“不要下载”和“下载并存储在本地系统”。除了展示的内容,部分文章还有附件供读者阅读。当采集器采集文章时,如果要删除附件采集,可以在此处选择“下载并存储在本地系统”。这时候下面会自动出现一个填充目标附件位置的标签条目,如图(2-15).然后填写可以用来定位附件的开始标记和结束标记在出现的两个字段中,点击。右边可以预览你想要的采集的附件信息,当采集器只需要采集文章的内容,而你不想要的时候图2-15【作者姓名获取方式】:当文章采集要在采集下方的文章内容中添加作者姓名时,您可以选择“不下载”。可以选择“指定作者姓名”,然后在下方【指定作者姓名为】右侧的输入框中填写要起草的作者姓名。当文章采集器想直接获取时原文章内容中的作者姓名,可以选择“采集 from the page”,下面会自动出现一个标签条目,填写目标作者的位置,如sho wn 在图 (2-16).图 2-16。然后在出现的两个条目中填写可用于定位作者位置的开始和结束标签。单击。右侧可以预览你想要的采集的作者信息。:【信息获取方式】:一般文章会标识其内容的来源。我们这里也特意添加了采集数据源功能,方便文章采集器获取源信息。

有时候采集people想在采集往下的文章内容中添加自己设置的数据源信息时,可以选择“指定源名称”,然后点击【指定数据源名称】 ] 下面为] 在右侧的输入框中填写要设置的数据源的信息。当文章采集想直接获取原创的文章内容数据源信息时,可以选择“采集source from the page”,会自动出现一个标签填写目标数据源的位置下面。项,如图(2-17)。然后在出现的两个字段中填写可以定位数据源位置的开始标记和结束标记。点击右侧预览文章数据采集的图2-17【获取摘要的方法】:一般文章会附带一些内容摘要,为文章提供内容摘要,这里我们也特意添加了采集摘要的功能。当文章当采集器想直接从文章内容开头截取一部分内容作为这个文章内容的摘要,选择从正文截取摘要,然后输入你想要的想在下方【获取正文】右侧的输入框中截取文章开头的内容中的字符数,有时候如果文章采集想直接获取原来的文章内容摘要信息,他们可以从页面中选择采集摘要,然后它会自动出现在下面的标签填写项为loca出现目标内容摘要,如图(2-18).图2-18 然后在出现的两个填写位置中填写可用于定位内容摘要位置的开始标签和结束标签。点击右侧可以预览你想要的信息采集文章内容摘要。

如果采集的文章中没有配置摘要,可以选择不采集。当所有必填的设置项都填好后,点击,本页填写的信息就设置成功了。以上四步都设置好后,一个完整的文章list内容页文章采集任务就设置好了。 RSS文章List采集Task Settings RSS 是站点与其他站点共享内容(也称为聚合内容)的一种简单方式,通常用于文章 和其他网站的顺序@。 RSS已成为目前最成功的XML应用,为信息的快速传播搭建了技术平台,让每个人都成为潜在的信息提供者。目前很多大型的网站都提供了RSS支持。基于这种情况,我们还专门开发了自动采集RSS文章功能。接下来,我们将详细介绍如何采集RSS文章。 RSS文章采集也与文章表页文章的采集相同。首先创建一个采集任务,通过(图2-3).现在)中的四个步骤分别介绍。 【第一步:基础】:本任务的基础设置页面和采集文章表页文章的设置页面为一页,如图(2-3).提供的设置大部分相同,唯一不同的是:在“采集List Type”项中选择RSS链接,在“采集List Address”中需要填写@的RSS格式的XML链接地址采集文章,例如新浪RSS频道文章中心下的文章要闻列表(HYPERLINK "/news/marquee/ddt.xml" /news/marquee/ddt.xml),功能和设置以及其他项目采集文章list 页面的选项相同。

这里不多介绍。 【步骤二:列表页面】:该页面的设置项主要包括内容去重的设置和填写RSS文章content页面的链接地址。内容页链接的设置是为下一步采集具体文章内容做准备,如图(2-19)。具体操作是在RSS文章中打开一个文章 @list page and put this 在这里的内容链接地址栏中填写文章content页面的地址,然后点击预览即可,这个设置的原因和文章content显示的原因是一样的普通文章列表的页面,使用相同的内容展示页面,这里需要注意的是此项必须填写。 图2-19【步骤3:内容页面】:该页面的设置功能是采集文章的列表页中的第三个步骤内容页设置的功能是一样的,如图(2-20)。具体操作也一样,就不介绍了图2-20【步骤4:附加】:该页面的样式如图(2-21) 图2-21 该页面设置的功能和操作方法同上) 采集文章 列表页面。通过以上步骤设置后,一个完整的RSS文章采集任务就完成了,接下来就可以采集RSS文章了。 2.1.3 修改任务 当信息采集器想修改已经创建的任务中的设置信息时,只需点击要更改的任务名称,在任务设置界面进行更改弹出。 2.1.4 删除任务时信息采集器 出于某种原因,采集一个文章在文章的列表中,要删除时可以选择采集任务删除,点击,采集任务将被删除。

2.1.5 启用和禁用任务 为了方便地启用和禁用采集任务,我们特地在任务列表的上半部分添加了这两个功能,如图(2-1).当采集管理者想要启用某些任务时,只需选择要启用的任务,然后点击,该任务被启用;当采集管理者想要停止一些已经启用的任务时, 2.1.6 设置计划 计划主要是为采集tasks 设置定时启动,此功能为采集器提供信息,智能采集方案方便采集器的维护,同时也提高了文章的时效性,具体操作点击弹出如图(2-22)界面,图2 -22,然后在弹出框中详细填写配置项,点击,采集plan添加成功。注意:配置项中的任务名称是指任务n 采集 任务的名称。此项必须正确填写,以确保任务执行正确。 2.1.7 设置模板 在2.1.1 部分,我们提到了设置模板的功能。下面我们来具体介绍一下。当文章管理员需要把某个采集设置为模板以备将来使用时,直接选择采集task,点击采集task右侧操作中的“设置为模板”记录。然后,这个采集task会作为模板保存到【Task Template】列中。 2.1.8 采集记录管理采集记录管理的功能配置在名称旁边每个采集任务方便信息采集器对采集记录被维护。

点击采集任务名称左侧的【查看记录】,进入采集记录管理页面,如图(2-23)。该页面共有三个设置,分别是:重置采集 @status,删除采集status,清除采集status。采集的文章的来源信息记录在下面的列表页,这个功能方便采集器查看采集信息下的文章的来源,每条记录都有一个链接,如图2-23 重置采集状态 每个采集任务执行后,所有采集记录都会列在这个页面上。当信息采集zhe发现采集down的一个文章的显示格式或内容不正确或不符合自己的需要时,需要更改任务设置,然后重新采集 @为这条文章,但必填 当没有被其他采集down的文章重新采集时,信息采集可以选择这条记录,点击,这条的采集标记记录将变为“不采集”。接下来采集器可以更改任务的设置,af ter更改,然后采集再次,现在你需要重新采集文章采集down,并将其保存到指定的文章组件如果采集人不想要不满意文章,可以删除文章source 列中原来的文章。删除采集记录,因为系统执行采集任务会记录在采集记录管理中。如果下次执行任务,如果采集记录管理中有采集记录,则跳过这条记录,而不是采集。所以如果@当采集器想要重新采集某条或部分文章记录,你必须在这里删除这些采集记录,然后执行任务,系统会重置文章这些记录采集又下来了。

具体操作是选中要删除的记录,点击,该记录就会被删除。清除采集记录 当采集器想在某个任务中重新采集文章时,则必须在该页面删除该任务中的所有记录。为了方便删除,我们提供了清除采集记录的功能。只要你点击这个页面,所有的记录都会被删除。 2.2 任务控制台 任务控制台主要提供采集任务的启停管理。其控制界面如图(2-24)。蓝色的任务工作区会显示采集任务进程的信息。所有要执行的任务必须在任务控制台中启动。需要说明的是这里是如果信息采集器已经创建了很多采集任务,但是你想指定任务什么时候执行,你必须在任务中把其他没有执行的任务的状态改为禁用状态设置,然后采集。如果要在采集的过程中停止采集,直接点击,采集Task就会被终止。图2-242.3 任务日志这里的功能主要是详细记录采集任务的操作,比如启动一个任务然后执行,这里会记录任务执行过程中发生的操作。如图(2-25):图2) -25 该功能用于采集任务有问题的时候查找和排查问题,当采集管理员不想在这里显示日志时,可以选择日志并单击它。如果管理员想要删除所有日志,点击,此时页面上的所有日志都会被清除。

另外,这里还配置了模糊查询功能。为了方便管理员查询记录。 2.4 任务模板 该模块主要存储2.1.7部分设置的任务模板,同时也记录了任务模板的相关信息,如模板名称、模板描述、采集地址。此外,其模块中还配置了模糊查询功能,方便管理员快速查找。如图(2-26):图2-26 如果管理员不需要某个模板,当您想删除它时,可以选择该模板并点击它。2.5 回收站删除任务信息记录在页面显示如下图,这里可以恢复删除的记录,只需要选中记录,点击按钮,如果确定要完全删除记录,点击记录下图中完全删除操作。 图2-273.HYPERLINK "7:8080/system/reptile/manager.jsp" \o "数据抓取管理" \t "right" 数据抓取管理3.功能说明@1 HYPERLINK "7:8080/system/reptile/manager.jsp" \o "数据采集管理" \t "right" 数据采集管理概述 根据用户的设置方法提取外部数据库中的数据信息并存储在本产品使用的数据库中,数据以文章的形式显示(即任意数据库表中的数据为以用户指定的方式捕获到本产品的文章表中)。

其特点:可以对任意数据库进行操作,可以联合抓取多张表的数据。操作简单,用户自定义任务和数据提取。您可以制定计划,定期、定量地从所需数据库中提取数据,并展示在本产品的前台网站文章页面上。 3.2 任务设置 图3-1 当您需要添加新的数据采集任务时,可以在弹出的页面中点击 添加采集任务。数据抓包的任务设置分为三步(基本信息设置、抓包信息设置、表属性映射设置),填写任务时必须一步一步填写。在每个步骤中,所有带有符号的项目都是必需的。 3.2.1 基本信息设置在第一步建立数据采集任务的基本信息页面。需要填写的项目如图(3-2)。图3-2【任务名称】:这个文章抓取任务的任务名称。当这个任务处于“启用”状态时, 执行抓取任务时,会执行此任务;当任务处于“禁用”状态时,执行抓取任务时会执行此任务。该任务不执行。 [目标列]:在这里你可以选择将捕获的文章放在该列文章源中。文章源列的选择基于用户的需求。选择单击时,将弹出用于选择页面组件的页面,如图所示图中(3-3)。在页面上选择需要的列文章source,然后点击。执行爬取任务后,抓取到的文章直接存储在指定列文章source中。图3-3【数据库连接池】:源数据库和新数据库都需要在系统管理下的数据库链接池中进行配置。

这里的数据库链接池要设置为数据源所在的连接池。 【每次最多抓取】:这里可以选择每次要抓取的文章的数量。 【发布状态】:这里有两个选项:“需要抓取后审核发布”和“抓取后立即发布”。当数据爬虫需要对抓取的文章进行审核,审核通过后可以发布,可以选择“抓取后需要审核后发布”。当数据爬虫审核抓获的文章When 未经审核发布。您可以选择“抓取后立即发布”。设置好需要的项目后,点击 ,进入第二步列表页面的设置。 3.2.2 抓包信息设置在抓包信息设置页面第二步显示(3-4)填一条sql查询语句。图3-4【任务名称】:这里显示的名字是第一步定义的任务名称。【抓取数据的条件设置】:数据爬虫可以根据自己的需要输入上图中的SQL语句,但必须保证SQL的正确性,否则点击Save After即会出现如图(3-5))的提示信息 图3-53.2.3 表属性映射设置在第三步表属性映射设置的设置页面如图图中(3-6) ,主要是数据抓取器设置了title字段、body字段、抓取文本格式、唯一标识字段、作者、数据源、摘要、关键词、Join时间。保存表属性映射设置,以便设置任务。

图3-63.2. 当数据采集器想要重新修改已经创建的任务中的设置信息时,只需点击要更改的任务记录后的任务设置即可。只需在界面中进行更改。 3.2 当数据抓取器由于某种原因不需要抓取文章 列表中的文章 时。如果你想删除它,你可以选择你要删除的抓取任务,点击它,这个抓取任务就被删除了。 3.2.6 开启任务和关闭任务 为了方便开启和关闭抓取任务的操作,我们特地在任务列表的上半部分增加了这两个功能,如图(3- 1).当数据采集管理器想要开启某些任务时,只需选择要开启的任务,然后点击,任务开启;当数据采集管理器想要停止一些已经开启的任务时,选择要禁用的任务,点击即可。3.2.7 设置计划 设置计划主要是为爬取任务的定时设置,该功能为数据爬虫提供智能爬取计划,方便数据抓取同时也提高了文章的时效性,具体操作是点击弹出界面如图3-7)。如图3-7,然后填写配置项在弹出框中点击,爬取计划添加成功3.2.8 Crawl 当数据爬虫想要管理已经创建的任务记录,只需点击任务记录后进入爬取记录管理界面如图(3-8).在此页面上,可以删除和清除记录。注意:这里删除的记录不会影响已经抓到文章source列的记录。

图3-83.3 任务控制台 任务控制台主要提供抓取任务的启动和停止管理。其控制界面如图(3-9)。所有任务要执行,必须在任务控制台中启动。这里需要注意的是,如果信息抓取器已经创建了很多抓取任务,但是想要要执行指定的任务,必须在任务设置中将其他没有执行的任务的状态改为禁用状态,然后进行爬取,如果在爬取过程中想停止爬取,直接点击,爬取任务图3-93.4 任务日志 这里的功能主要是详细记录抓包操作,比如启动一个任务然后执行,这里会记录执行过程中发生的操作如图(3-10):图3-10 这个函数的作用是的,当爬取任务出现问题的时候,方便我们查找问题和排查问题。当爬网管理器不希望在此处显示日志,您可以选择日志并单击它。如果管理员想要删除所有日志,点击所有日志,此时页面上的所有日志都会被清除。此外,这里还配置了模糊查询功能。方便管理人员查询记录。 3.5 回收站如下图 删除的任务信息记录显示在页面上,可以恢复删除的记录,只需选中该记录,点击按钮即可。如果您确定要完全删除一条记录,请点击下图完全删除该记录。 图3-11

好与坏,关键在于大大的噢!使用者噢~~

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-08-18 19:11

我是一个好人,一个伟大的恩人。

好与坏的关键在于用户!

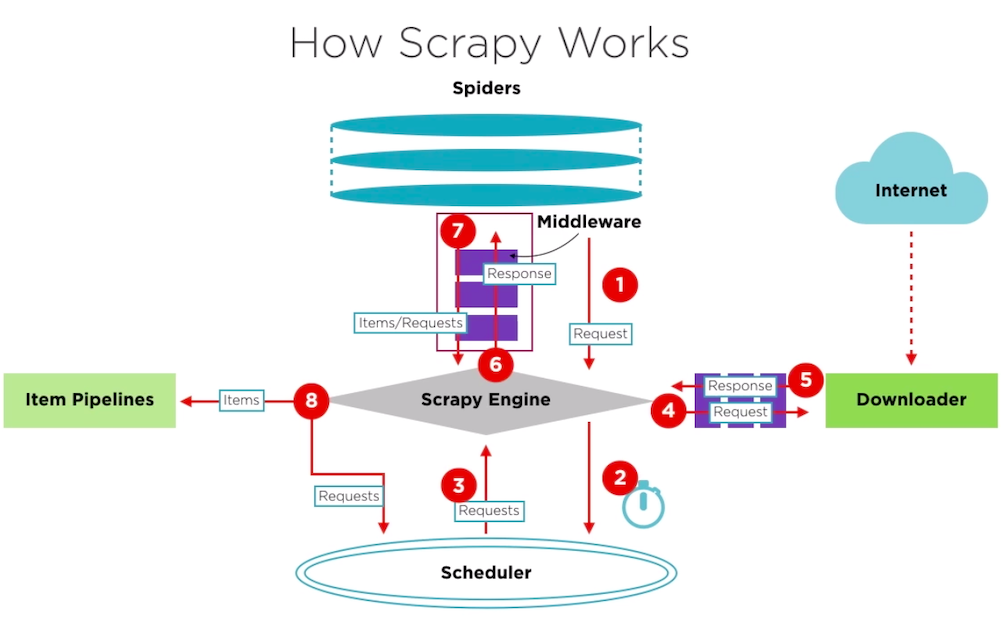

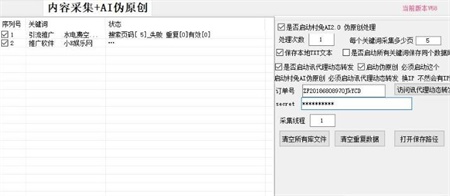

Scrapy是一个常用的数据采集工具;

Selenium 是一个浏览器自动化测试工具;

结合Scrapy的数据处理机制和Selenium,模拟真实浏览器获取数据(如:自动登录、自动翻页等)。 采集可以做得更好。

关于 Scrapy

Scrapy 是开发者在互联网上常用的数据采集 工具之一。我们已经习惯了通过 API 获取数据,但是一些网站出于“性能或安全”的原因仍然使用某些技术。该方法特意避开API传输数据(如静态页面、一次性令牌等)。因此,为了能够采集得到这些数据,我们可以分析站点和标签结构,然后通过使用Scrapy采集数据。

简单介绍一下Scrapy框架的作用,具体怎么帮我们采集数据?先来看看Scrapy的结构:

Scrapy 的数据流由 Scrapy Engine 控制,流程如下:

引擎初始化并获取来自 Spider 的请求。将请求放入调度程序。调度器将 Requests 一一发送给 Scrapy Engine 进行消费。 Scrapy Engine 通过下载器中间件将请求发送给下载器。下载器将Request获取的页面作为响应结果返回给Scrapy Engine。 Scrapy Engine 接收来自 Downloader 的 Response 并将其发送到 Spider Middleware 进行处理。 Spider 处理响应并将项目返回给 Scrapy 引擎。 Scrapy Engine将处理后的item发送到Item Pipeline,同时将处理后的信号发送给调度器(Scheduler)请求下一个采集请求。

重复以上步骤处理采集请求,直到调度器中没有新的请求。

Scrapy 安装教程:

Scrapy 项目创建

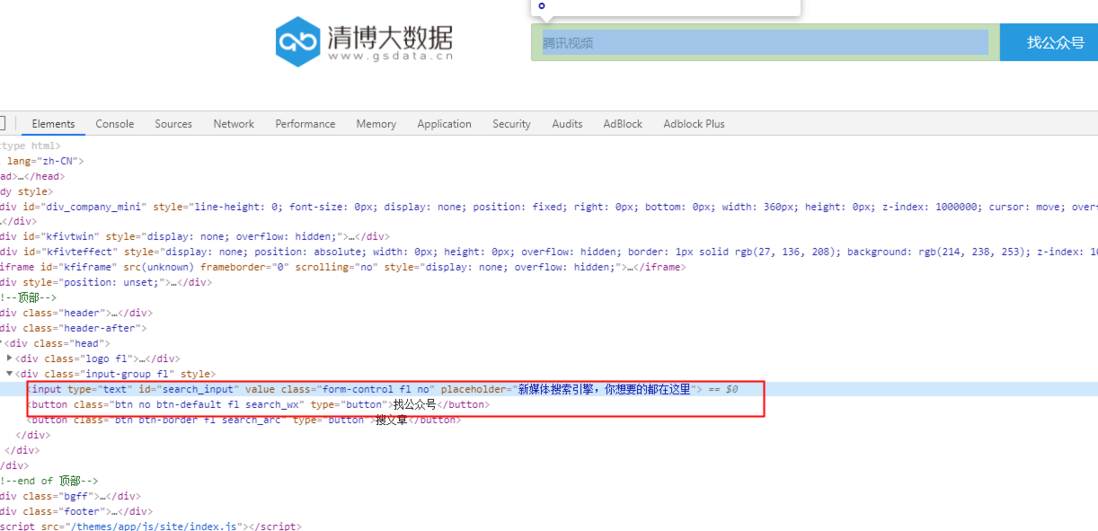

今天以清博大数据为例,完成自动登录、自动搜索、数据采集。

在文件根目录执行:

scrapy startproject qingbo

然后进入目录qingbo/并执行:

scrapy genspider crawl gsdata.cn

获取以下目录:

qingbo/

scrapy.cfg # deploy configuration file

qingbo/ # project's Python module, you'll import your code from here

__init__.py

items.py # project items definition file

middlewares.py # 浏览器的启动和访问方式在这操作

pipelines.py # 处理好后的数据在这做最后处理

settings.py # project settings file

spiders/ # a directory where you'll later put your spiders

__init__.py

crawl.py # 访问的连接和爬取后的数据在这里处理

其实在Scrapy中如何结合Selenium的关键在middlewares.py

具体的封装方法请参考:

关于硒

Selenium 是一种开源自动化测试框架,可通过不同的浏览器和平台验证 Web 应用程序。目前支持Python、Java、PHP等多种语言调用

Selenium 测试直接在浏览器中运行,就像真实用户一样,因此您可以利用这一点更好地执行数据采集。

Python Selenium 安装教程:

硒案例

未登录可直接访问青博大数据腾讯视频

如果没有任何反应,会跳转到登录页面进行登录。Selenium的环境安装上面已经讲到了,这里直接上代码:

网站打开

options = Options()

options.headless = False

driver = webdriver.Firefox(options=options)

driver.get('https://u.gsdata.cn/member/login')

driver.implicitly_wait(10) # 页面打开需要加载时间,所以建议加个静默等待

登录操作

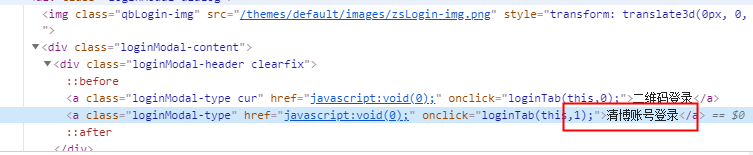

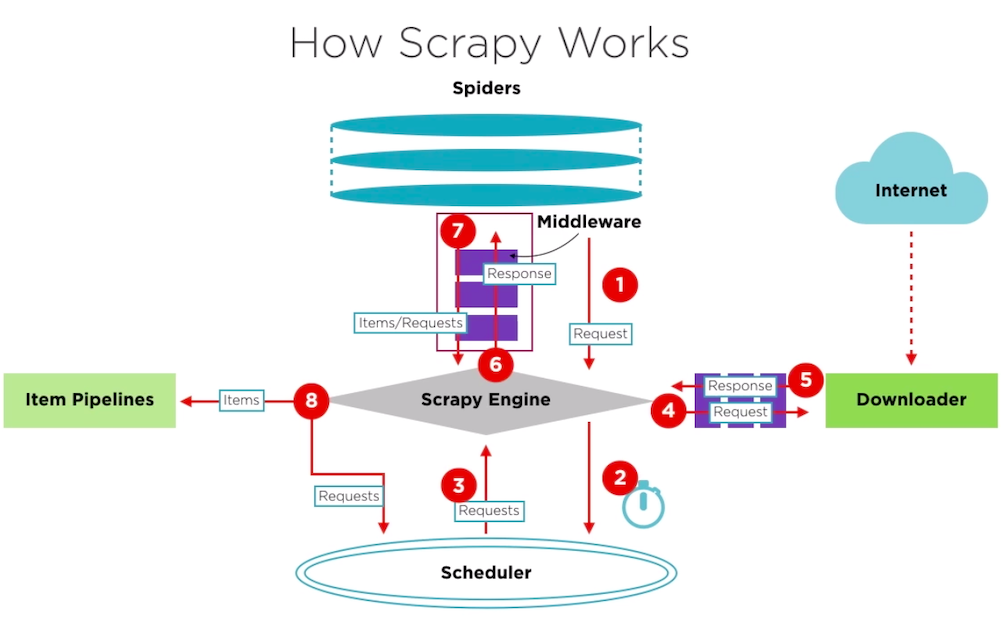

可以找到两个选项卡,分别是:二维码登录和清博账号登录。

页面已经打开,如何进入清博账号登录标签?

这里我们需要了解Xpath(XML Path Language),它是一种用于确定XML文档某部分位置的语言。

简单来说,我们可以使用Xpath定位到“清博账户登录”的Tab

driver.find_element_by_xpath(".//div[@class='loginModal-content']/div/a[2]").click()

然后导航到帐户密码框并填写信息:

driver.find_element_by_xpath(".//input[@name='username']").send_keys("username")

driver.find_element_by_xpath(".//input[@name='password']").send_keys("password")

最后点击登录按钮:

登录成功! ~

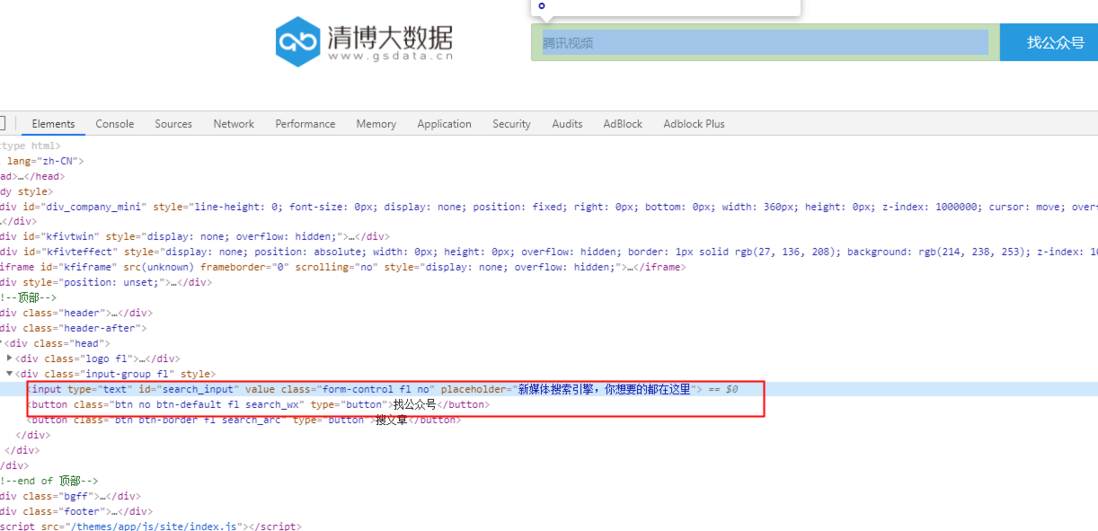

查询操作

driver.get('http://www.gsdata.cn/')

driver.find_element_by_xpath(".//input[@id='search_input']").send_keys("腾讯视频")

driver.find_element_by_xpath(".//button[@class='btn no btn-default fl search_wx']").click()

driver.implicitly_wait(5)

经过搜索,得到如下结果:

使用Xpath定位腾讯视频的a标签,然后点击进入腾讯视频的数据内容页面:

driver.find_element_by_xpath(

".//ul[@class='imgword-list']/li[1]/div[@class='img-word']/div[@class='word']/h1/a").click()

driver.implicitly_wait(5)

内容页面

当你来到这里时,你感到惊讶吗?现在可以通过Xpath定位获取需要处理的内容,这里不再赘述。

关闭操作

driver.close()

获取数据后,如果没有其他操作,可以关闭浏览器。

总结

本章介绍了 Scrapy 和 Selenium 的基本概念和一般用法。总的来说,它可以帮助我们在解决一些问题时提供新的解决方案和思路。

参考 查看全部

好与坏,关键在于大大的噢!使用者噢~~

我是一个好人,一个伟大的恩人。

好与坏的关键在于用户!

Scrapy是一个常用的数据采集工具;

Selenium 是一个浏览器自动化测试工具;

结合Scrapy的数据处理机制和Selenium,模拟真实浏览器获取数据(如:自动登录、自动翻页等)。 采集可以做得更好。

关于 Scrapy

Scrapy 是开发者在互联网上常用的数据采集 工具之一。我们已经习惯了通过 API 获取数据,但是一些网站出于“性能或安全”的原因仍然使用某些技术。该方法特意避开API传输数据(如静态页面、一次性令牌等)。因此,为了能够采集得到这些数据,我们可以分析站点和标签结构,然后通过使用Scrapy采集数据。

简单介绍一下Scrapy框架的作用,具体怎么帮我们采集数据?先来看看Scrapy的结构:

Scrapy 的数据流由 Scrapy Engine 控制,流程如下:

引擎初始化并获取来自 Spider 的请求。将请求放入调度程序。调度器将 Requests 一一发送给 Scrapy Engine 进行消费。 Scrapy Engine 通过下载器中间件将请求发送给下载器。下载器将Request获取的页面作为响应结果返回给Scrapy Engine。 Scrapy Engine 接收来自 Downloader 的 Response 并将其发送到 Spider Middleware 进行处理。 Spider 处理响应并将项目返回给 Scrapy 引擎。 Scrapy Engine将处理后的item发送到Item Pipeline,同时将处理后的信号发送给调度器(Scheduler)请求下一个采集请求。

重复以上步骤处理采集请求,直到调度器中没有新的请求。

Scrapy 安装教程:

Scrapy 项目创建

今天以清博大数据为例,完成自动登录、自动搜索、数据采集。

在文件根目录执行:

scrapy startproject qingbo

然后进入目录qingbo/并执行:

scrapy genspider crawl gsdata.cn

获取以下目录:

qingbo/

scrapy.cfg # deploy configuration file

qingbo/ # project's Python module, you'll import your code from here

__init__.py

items.py # project items definition file

middlewares.py # 浏览器的启动和访问方式在这操作

pipelines.py # 处理好后的数据在这做最后处理

settings.py # project settings file

spiders/ # a directory where you'll later put your spiders

__init__.py

crawl.py # 访问的连接和爬取后的数据在这里处理

其实在Scrapy中如何结合Selenium的关键在middlewares.py

具体的封装方法请参考:

关于硒

Selenium 是一种开源自动化测试框架,可通过不同的浏览器和平台验证 Web 应用程序。目前支持Python、Java、PHP等多种语言调用

Selenium 测试直接在浏览器中运行,就像真实用户一样,因此您可以利用这一点更好地执行数据采集。

Python Selenium 安装教程:

硒案例

未登录可直接访问青博大数据腾讯视频

如果没有任何反应,会跳转到登录页面进行登录。Selenium的环境安装上面已经讲到了,这里直接上代码:

网站打开

options = Options()

options.headless = False

driver = webdriver.Firefox(options=options)

driver.get('https://u.gsdata.cn/member/login')

driver.implicitly_wait(10) # 页面打开需要加载时间,所以建议加个静默等待

登录操作

可以找到两个选项卡,分别是:二维码登录和清博账号登录。

页面已经打开,如何进入清博账号登录标签?

这里我们需要了解Xpath(XML Path Language),它是一种用于确定XML文档某部分位置的语言。

简单来说,我们可以使用Xpath定位到“清博账户登录”的Tab

driver.find_element_by_xpath(".//div[@class='loginModal-content']/div/a[2]").click()

然后导航到帐户密码框并填写信息:

driver.find_element_by_xpath(".//input[@name='username']").send_keys("username")

driver.find_element_by_xpath(".//input[@name='password']").send_keys("password")

最后点击登录按钮:

登录成功! ~

查询操作

driver.get('http://www.gsdata.cn/')

driver.find_element_by_xpath(".//input[@id='search_input']").send_keys("腾讯视频")

driver.find_element_by_xpath(".//button[@class='btn no btn-default fl search_wx']").click()

driver.implicitly_wait(5)

经过搜索,得到如下结果:

使用Xpath定位腾讯视频的a标签,然后点击进入腾讯视频的数据内容页面:

driver.find_element_by_xpath(

".//ul[@class='imgword-list']/li[1]/div[@class='img-word']/div[@class='word']/h1/a").click()

driver.implicitly_wait(5)

内容页面

当你来到这里时,你感到惊讶吗?现在可以通过Xpath定位获取需要处理的内容,这里不再赘述。

关闭操作

driver.close()

获取数据后,如果没有其他操作,可以关闭浏览器。

总结

本章介绍了 Scrapy 和 Selenium 的基本概念和一般用法。总的来说,它可以帮助我们在解决一些问题时提供新的解决方案和思路。

参考

无忧主机教您半小时完成dedecms完全设置的BUG解决方法

采集交流 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-08-12 06:13

对于网站的每日更新,很多站长选择使用采集来丰富网站的内容。 采集虽然可以丰富网站的内容,但是很容易被搜索引擎判断为作弊,存在降级停收录的风险。今天有用户问:采集完文章后dedecms生成文档后的时间是采集时的时间,这个问题怎么解决?带着这个疑问,让我们开始今天的文档分享。 dedecms采集文档审核后,生成的文档会在采集时间显示如下:

1、 首先点击进入我们的控制面板,然后找到文件管理选项。

2、点击进入,找到我们网站的根目录。

3、进入这个目录后,找到我们程序后端的路径:/dede/archives_do.php,点击编辑。

4、修改代码操作,

找到代码:

$maintable = ( trim($row[maintable])== ? dede_archives : trim($row[maintable]) );

$dsql>ExecuteNoneQuery("Update `dede_arctiny` set arcrank= where id=$aid ");

if($row[issystem]==)

{

$dsql>ExecuteNoneQuery("Update `"trim($row[addtable])"` set arcrank= where aid=$aid ");

}

else

{

$dsql>ExecuteNoneQuery("Update `$maintable` set arcrank= where id=$aid ");

}

$pageurl = MakeArt($aidfalse);

}

ShowMsg("成功审核指定的文档!"$ENV_GOBACK_URL);

修改为:

$maintable = ( trim($row[maintable])== ? dede_archives : trim($row[maintable]) );

$newdate = time();

$dsql>ExecuteNoneQuery("Update `dede_arctiny` set sortrank=$newdatesenddate=$newdatearcrank= where id=$aid ");

if($row[issystem]==)

{

$dsql>ExecuteNoneQuery("Update `"trim($row[addtable])"` set sortrank=$newdatepubdate=$newdatesenddate=$newdatearcrank= where aid=$aid ");

}

else

{

$dsql>ExecuteNoneQuery("Update `$maintable` set sortrank=$newdatepubdate=$newdatesenddate=$newdatearcrank= where id=$aid ");

}

$pageurl = MakeArt($aidfalse);

}

ShowMsg("成功审核指定的文档!"$ENV_GOBACK_URL);

上一篇:dedecms文章添加跳转属性,打开空白BUG解决

下一篇:无忧主机教你半小时完成dedecms完整设置 查看全部

无忧主机教您半小时完成dedecms完全设置的BUG解决方法

对于网站的每日更新,很多站长选择使用采集来丰富网站的内容。 采集虽然可以丰富网站的内容,但是很容易被搜索引擎判断为作弊,存在降级停收录的风险。今天有用户问:采集完文章后dedecms生成文档后的时间是采集时的时间,这个问题怎么解决?带着这个疑问,让我们开始今天的文档分享。 dedecms采集文档审核后,生成的文档会在采集时间显示如下:

1、 首先点击进入我们的控制面板,然后找到文件管理选项。

2、点击进入,找到我们网站的根目录。

3、进入这个目录后,找到我们程序后端的路径:/dede/archives_do.php,点击编辑。

4、修改代码操作,

找到代码:

$maintable = ( trim($row[maintable])== ? dede_archives : trim($row[maintable]) );

$dsql>ExecuteNoneQuery("Update `dede_arctiny` set arcrank= where id=$aid ");

if($row[issystem]==)

{

$dsql>ExecuteNoneQuery("Update `"trim($row[addtable])"` set arcrank= where aid=$aid ");

}

else

{

$dsql>ExecuteNoneQuery("Update `$maintable` set arcrank= where id=$aid ");

}

$pageurl = MakeArt($aidfalse);

}

ShowMsg("成功审核指定的文档!"$ENV_GOBACK_URL);

修改为:

$maintable = ( trim($row[maintable])== ? dede_archives : trim($row[maintable]) );

$newdate = time();

$dsql>ExecuteNoneQuery("Update `dede_arctiny` set sortrank=$newdatesenddate=$newdatearcrank= where id=$aid ");

if($row[issystem]==)

{

$dsql>ExecuteNoneQuery("Update `"trim($row[addtable])"` set sortrank=$newdatepubdate=$newdatesenddate=$newdatearcrank= where aid=$aid ");

}

else

{

$dsql>ExecuteNoneQuery("Update `$maintable` set sortrank=$newdatepubdate=$newdatesenddate=$newdatearcrank= where id=$aid ");

}

$pageurl = MakeArt($aidfalse);

}

ShowMsg("成功审核指定的文档!"$ENV_GOBACK_URL);

上一篇:dedecms文章添加跳转属性,打开空白BUG解决

下一篇:无忧主机教你半小时完成dedecms完整设置

PHP虚拟主机重新安装一个dedecmsdedecms来配置测试了两种解决方法

采集交流 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-08-11 07:30

做网站优化的站长朋友都知道,每天要定时发布一些文章,但是如果几个网站也可以这样发布,如果站点多,手动更新难免效率相对较低。有什么办法可以提高效率吗?后来站长朋友了解到,dedecms后台有系统默认自动采集功能,只要配置好就可以使用,所以用的人多,所以用这个功能有利有弊如果采集的内容结束了会导致服务器很卡。建议站长朋友慎用,或者晚上使用。主机无忧小编在网上看到很多站长朋友反映有这样的问题,就是采集当时只能使用采集第一页数据,以下数据在采集,即采集的数据不完整。如何解决这个问题?为了查明原因,小编不得不在PHP虚拟主机上重新安装了一个织梦dedecms来配置测试。经过分析,找到了两种解决方案。下面我们来详细梳理一下。第一种:

1:首先登录主机无忧会员中心,找到主机管理控制面板。

2:点击控制面板-进入文件管理

3:点击进入文件管理-找到public_html根目录。

4:按照路径找到dede/template/co_gather_start.htm

5:找到文件后,点击编辑,修改如下代码:to:即把上面代码中的数字5改为1。

第二种方法: 1 该方法的步骤与上述方法相同。直接找到include/dede采集.class.php文件。 2:查找 if($status = TRUE || $urlnum >= $mytotal) 中断;删除或注释掉这行代码,你就完成了。按照上面的两种方法,就可以解决了。修改完成后需要登录后台更新缓存。 查看全部

PHP虚拟主机重新安装一个dedecmsdedecms来配置测试了两种解决方法

做网站优化的站长朋友都知道,每天要定时发布一些文章,但是如果几个网站也可以这样发布,如果站点多,手动更新难免效率相对较低。有什么办法可以提高效率吗?后来站长朋友了解到,dedecms后台有系统默认自动采集功能,只要配置好就可以使用,所以用的人多,所以用这个功能有利有弊如果采集的内容结束了会导致服务器很卡。建议站长朋友慎用,或者晚上使用。主机无忧小编在网上看到很多站长朋友反映有这样的问题,就是采集当时只能使用采集第一页数据,以下数据在采集,即采集的数据不完整。如何解决这个问题?为了查明原因,小编不得不在PHP虚拟主机上重新安装了一个织梦dedecms来配置测试。经过分析,找到了两种解决方案。下面我们来详细梳理一下。第一种:

1:首先登录主机无忧会员中心,找到主机管理控制面板。

2:点击控制面板-进入文件管理

3:点击进入文件管理-找到public_html根目录。

4:按照路径找到dede/template/co_gather_start.htm

5:找到文件后,点击编辑,修改如下代码:to:即把上面代码中的数字5改为1。

第二种方法: 1 该方法的步骤与上述方法相同。直接找到include/dede采集.class.php文件。 2:查找 if($status = TRUE || $urlnum >= $mytotal) 中断;删除或注释掉这行代码,你就完成了。按照上面的两种方法,就可以解决了。修改完成后需要登录后台更新缓存。

关于赛得信手机号码注册方式的具体介绍(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-08-08 22:11

文章采集完毕后,通过赛德信扫描文章页面数据二维码获取读者注册参与赛德信app的信息。

赛德信e-saas商城抓取服务产品:1、扫描下面二维码下载注册。扫描二维码进入产品页面,点击注册可以进入到赛德信产品首页。注册用户即可开通扫描码注册服务。2、如果没有下载,可以在赛德信的公众号(赛德信)里面,点击:我的→我的我的赛事,随时随地注册赛事。

转载

我是这样注册的,图片上传后他会自动识别的,很方便,希望能够帮到你。

就这个问题问过招商那边,貌似是他们的技术有几种方式提供的。

赛得信目前提供两种注册方式,分别是手机号码注册和链接注册,两种方式都需要对应手机号码,下载安装或注册后只有对应信息才能进行认证和打赏。赛得信支持手机号码注册,即客户登录赛得信app后选择“手机号码注册”即可,手机号码需为工信部颁发的手机号码。该方式具有简单快捷、可信赖的特点,常用于短信平台及第三方聚合平台。

常见的链接注册方式是客户通过链接注册获取其他人的注册信息或认证信息。如通过天天领红包app“我的奖品”获取本人奖品认证信息,手机验证码等。建议链接注册方式,认证后可以进行大额奖品抽奖,未使用过的订单还可免费积分获取。相比于其他平台,赛得信有一个特色功能就是可以从个人名下的商家获取流量,例如“我的抽奖”为个人创建一个“天天领红包”的抽奖专场,个人可以在该专场设置认证抽奖人数或者上传身份证等,并可同步到其他商家平台。以上就是关于赛得信手机号码注册方式的具体介绍,如果需要更详细的了解,欢迎继续关注赛得信。 查看全部

关于赛得信手机号码注册方式的具体介绍(图)

文章采集完毕后,通过赛德信扫描文章页面数据二维码获取读者注册参与赛德信app的信息。

赛德信e-saas商城抓取服务产品:1、扫描下面二维码下载注册。扫描二维码进入产品页面,点击注册可以进入到赛德信产品首页。注册用户即可开通扫描码注册服务。2、如果没有下载,可以在赛德信的公众号(赛德信)里面,点击:我的→我的我的赛事,随时随地注册赛事。

转载

我是这样注册的,图片上传后他会自动识别的,很方便,希望能够帮到你。

就这个问题问过招商那边,貌似是他们的技术有几种方式提供的。

赛得信目前提供两种注册方式,分别是手机号码注册和链接注册,两种方式都需要对应手机号码,下载安装或注册后只有对应信息才能进行认证和打赏。赛得信支持手机号码注册,即客户登录赛得信app后选择“手机号码注册”即可,手机号码需为工信部颁发的手机号码。该方式具有简单快捷、可信赖的特点,常用于短信平台及第三方聚合平台。

常见的链接注册方式是客户通过链接注册获取其他人的注册信息或认证信息。如通过天天领红包app“我的奖品”获取本人奖品认证信息,手机验证码等。建议链接注册方式,认证后可以进行大额奖品抽奖,未使用过的订单还可免费积分获取。相比于其他平台,赛得信有一个特色功能就是可以从个人名下的商家获取流量,例如“我的抽奖”为个人创建一个“天天领红包”的抽奖专场,个人可以在该专场设置认证抽奖人数或者上传身份证等,并可同步到其他商家平台。以上就是关于赛得信手机号码注册方式的具体介绍,如果需要更详细的了解,欢迎继续关注赛得信。

动态IP代理IPHTTPS代理代理服务器长效代理长效IP(2)

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-08-08 12:39

目前,越来越多的用户使用代理IP。众所周知,代理IP实际上是通过隐藏自己的IP来达到偷偷访问网站的目的。

根据代理IP的使用时间,可分为长期IP和短期IP。这就是两者的区别。

动态IP代理IP代理HTTPS代理代理服务器长期代理长期IP

(1)长效IP代理

长期IP代理:顾名思义,就是指长期存在的IP地址。可以在代理选择的购买时间内重复使用。 ADSL拨号服务器可以保护局域网的安全,起到防火墙的作用,隔离内外网,提供监控网络和记录传输信息的功能,从而了解局域网的数据。一些行业。当然,这应该在行业许可范围内。

动态IP代理IP代理HTTPS代理代理服务器长期代理长期IP

(2)short-term IP 代理

短期IP代理:一般是指存活时间只有几分钟甚至几十秒的代理IP。在代理IP服务的使用中,短代理IP非常普遍,使用率非常高。其主要特点是:时效性短,一般在3-15分钟左右。不同时期价格不同。当然,时间越长,价格就越高。常见的应用场景包括爬虫采集、网页浏览、网络营销、SEO优化等。爬虫采集需要大量的动态代理IP、URL引导、关注。这种业务流程有一个共同的特点,就是需要不断的删除和替换大量的IP。事实上,最常用的是网络基础设施建设技术人员,他们知道如何使用和应用。

动态IP代理IP代理HTTPS代理代理服务器长期代理长期IP

最后推荐Bring Fun长期IP代理,他们的长期IP有很多优势。例如支持多平台、IP过滤、代理IP录制、多平台加速、任意IP交换、智能流媒体、自动IP交换、自定义代理IP API接口、集成简单、支持多种IP协议、支持HTTPS/Socks5 API等IP协议提取,按需设置。 查看全部

动态IP代理IPHTTPS代理代理服务器长效代理长效IP(2)

目前,越来越多的用户使用代理IP。众所周知,代理IP实际上是通过隐藏自己的IP来达到偷偷访问网站的目的。

根据代理IP的使用时间,可分为长期IP和短期IP。这就是两者的区别。

动态IP代理IP代理HTTPS代理代理服务器长期代理长期IP

(1)长效IP代理

长期IP代理:顾名思义,就是指长期存在的IP地址。可以在代理选择的购买时间内重复使用。 ADSL拨号服务器可以保护局域网的安全,起到防火墙的作用,隔离内外网,提供监控网络和记录传输信息的功能,从而了解局域网的数据。一些行业。当然,这应该在行业许可范围内。

动态IP代理IP代理HTTPS代理代理服务器长期代理长期IP

(2)short-term IP 代理

短期IP代理:一般是指存活时间只有几分钟甚至几十秒的代理IP。在代理IP服务的使用中,短代理IP非常普遍,使用率非常高。其主要特点是:时效性短,一般在3-15分钟左右。不同时期价格不同。当然,时间越长,价格就越高。常见的应用场景包括爬虫采集、网页浏览、网络营销、SEO优化等。爬虫采集需要大量的动态代理IP、URL引导、关注。这种业务流程有一个共同的特点,就是需要不断的删除和替换大量的IP。事实上,最常用的是网络基础设施建设技术人员,他们知道如何使用和应用。

动态IP代理IP代理HTTPS代理代理服务器长期代理长期IP

最后推荐Bring Fun长期IP代理,他们的长期IP有很多优势。例如支持多平台、IP过滤、代理IP录制、多平台加速、任意IP交换、智能流媒体、自动IP交换、自定义代理IP API接口、集成简单、支持多种IP协议、支持HTTPS/Socks5 API等IP协议提取,按需设置。

集搜客GooSeeker爬虫术语“主题”统一改为“任务”

采集交流 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2021-08-07 18:25

注:Jisouke的GooSeeker爬虫从V9.0.2版本开始,爬虫术语“主题”改为“任务”。在爬虫浏览器中,先给任务命名,然后创建规则,然后登录吉首可以查看任务的采集执行状态,管理线程URL,在“任务管理”中进行调度设置可客官网会员中心。

一、操作步骤

极速客的“飞行模式”是专门针对那些没有单独网址的弹窗网页的,也就是说点击后会弹出一个新的标签页,但网址不变。 “飞行模式”可以模拟人的操作。打开一个弹窗采集后,打开下一个弹窗,继续采集,这样弹窗的网页信息全部采集下。

以下示例以百度百家为例。虽然它的弹窗有独立的URL,但是这种情况下最简单的采集方法就是做关卡采集,但是为了给大家展示飞翔的采集,我们还是把它当成URL不变吧。步骤如下:

二、Case规则+操作步骤

第一步:打开网页

1.1,打开GS爬虫浏览器,输入网址,等待网页加载,然后点击“定义规则”,然后输入主题,最后再次勾选。主题名称不能重复。

第 2 步:定义一级规则

2.1,双击要采集的信息,打勾确认。一级规则可以随意标记一条信息,目的是让爬虫判断是否执行采集。

2.2,在这种情况下,点击每个文章标题,然后跟踪弹出的网页来采集数据。您需要编写用于定位每个单击对象的 xpath 表达式。我们可以使用“show xpath”功能来自动定位并找到能够定位到每个动作对象的xpath。但是对于非结构化的网页,“Display XPath”无法定位到所有的动作对象。您需要自己编写一个合适的 XPath。你可以看看XPath教程。

2.3,在连续动作中创建“点击”动作,填写下属主题名称“百度百家文章采集”,勾选“飞行模式”,填写xpath表达式和动作姓名

2.4,点击“保存规则”

第 3 步:定义二级规则

3.1,再次点击“定义规则”返回正常网页模式,然后点击第一篇文章文章标题,会弹出一个新窗口,在新的页面中定义二级规则窗口

3.2,双击要采集的信息进行标注,映射定位标注准确采集range

3.3,点击“测试”,如果输出结果没有问题,点击“保存规则”

第 4 步:捕获数据

4.1,在DS计数器中搜索一级规则并运行,点击成功会弹出一个新窗口,采集二级网页,采集完弹窗网页会自动关闭,然后点击下一步继续采集。这是flyby模式,智能跟踪弹窗采集到的数据。

注意:一级规则的后续动作执行成功后,会自动采集下级规则,所以不需要单独运行下级规则,尤其是下级规则级别规则没有独立的URL,运行时目标数据会失败。

注:以上为网站案例的采集规则,请根据目标网站的实际情况定义规则。另外,飞越模式为旗舰版功能,请先购买再按规则采集数据。

Tips:没有独立网址的网页如何加载和修改规则?

对于没有单独网址的网页,需要先点击那个页面,然后搜索规则,右键选择“只加载规则”,点击“规则”菜单->“后续分析”完成加载操作,可以修改规则。

比如这种情况下的二级规则是没有独立的URL。需要先加载一级规则,恢复到普通网页模式。单击文章 标题,将弹出一个新窗口。 (建议将操作写在第一级规则的备注中,方便阅读),然后右键点击第二级规则,选择“仅加载规则”。

Part 1 文章: "Continuous Action: 设置自动返回上级页面" Part 2 文章: "Continuous Code: 破解各种验证码"

如果您有任何问题,可以或

查看全部

集搜客GooSeeker爬虫术语“主题”统一改为“任务”

注:Jisouke的GooSeeker爬虫从V9.0.2版本开始,爬虫术语“主题”改为“任务”。在爬虫浏览器中,先给任务命名,然后创建规则,然后登录吉首可以查看任务的采集执行状态,管理线程URL,在“任务管理”中进行调度设置可客官网会员中心。

一、操作步骤

极速客的“飞行模式”是专门针对那些没有单独网址的弹窗网页的,也就是说点击后会弹出一个新的标签页,但网址不变。 “飞行模式”可以模拟人的操作。打开一个弹窗采集后,打开下一个弹窗,继续采集,这样弹窗的网页信息全部采集下。

以下示例以百度百家为例。虽然它的弹窗有独立的URL,但是这种情况下最简单的采集方法就是做关卡采集,但是为了给大家展示飞翔的采集,我们还是把它当成URL不变吧。步骤如下:

二、Case规则+操作步骤

第一步:打开网页

1.1,打开GS爬虫浏览器,输入网址,等待网页加载,然后点击“定义规则”,然后输入主题,最后再次勾选。主题名称不能重复。

第 2 步:定义一级规则

2.1,双击要采集的信息,打勾确认。一级规则可以随意标记一条信息,目的是让爬虫判断是否执行采集。

2.2,在这种情况下,点击每个文章标题,然后跟踪弹出的网页来采集数据。您需要编写用于定位每个单击对象的 xpath 表达式。我们可以使用“show xpath”功能来自动定位并找到能够定位到每个动作对象的xpath。但是对于非结构化的网页,“Display XPath”无法定位到所有的动作对象。您需要自己编写一个合适的 XPath。你可以看看XPath教程。

2.3,在连续动作中创建“点击”动作,填写下属主题名称“百度百家文章采集”,勾选“飞行模式”,填写xpath表达式和动作姓名

2.4,点击“保存规则”

第 3 步:定义二级规则

3.1,再次点击“定义规则”返回正常网页模式,然后点击第一篇文章文章标题,会弹出一个新窗口,在新的页面中定义二级规则窗口

3.2,双击要采集的信息进行标注,映射定位标注准确采集range

3.3,点击“测试”,如果输出结果没有问题,点击“保存规则”

第 4 步:捕获数据

4.1,在DS计数器中搜索一级规则并运行,点击成功会弹出一个新窗口,采集二级网页,采集完弹窗网页会自动关闭,然后点击下一步继续采集。这是flyby模式,智能跟踪弹窗采集到的数据。

注意:一级规则的后续动作执行成功后,会自动采集下级规则,所以不需要单独运行下级规则,尤其是下级规则级别规则没有独立的URL,运行时目标数据会失败。

注:以上为网站案例的采集规则,请根据目标网站的实际情况定义规则。另外,飞越模式为旗舰版功能,请先购买再按规则采集数据。

Tips:没有独立网址的网页如何加载和修改规则?

对于没有单独网址的网页,需要先点击那个页面,然后搜索规则,右键选择“只加载规则”,点击“规则”菜单->“后续分析”完成加载操作,可以修改规则。

比如这种情况下的二级规则是没有独立的URL。需要先加载一级规则,恢复到普通网页模式。单击文章 标题,将弹出一个新窗口。 (建议将操作写在第一级规则的备注中,方便阅读),然后右键点击第二级规则,选择“仅加载规则”。

Part 1 文章: "Continuous Action: 设置自动返回上级页面" Part 2 文章: "Continuous Code: 破解各种验证码"

如果您有任何问题,可以或

具有一定的参考价值,感兴趣的小伙伴们可以收藏方便以后

采集交流 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2021-08-07 18:19

这个文章主要介绍了Applecms采集最后没有播放地址时的解决方案。有一定的参考价值。有兴趣的朋友可以参考,有需要的朋友可以采集,方便日后参考。

Applecms采集最后没有播放地址?

这种情况一般是新手经常遇到的常见问题。如果需要查询问题,需要从以下几个方面入手:

1、Applecms采集最后没有播放地址的原因之一(是否添加相应播放器)

如果我们在准备采集一个资源站,首先要做的就是导入或者添加对应的播放器,比如我们要规划采集A资源站,那么我们就会找到一个资源站给我们提供下载播放器然后导入。至于是启动采集还是先添加播放器,我这里主题网推荐的操作是先添加播放器,然后去采集。正常情况下不会有特定的顺序,但有时在某些特殊情况下,采集添加资源并添加播放器后,将不会关联,无法播放。只有再次去采集才能出现播放按钮并流畅播放。导入播放器的步骤如下面的屏幕截图所示。

2、Applecms采集最后没有播放地址的第二个原因(是否采集接口添加错误)

以下是某资源站提供的Applecms采集接口,[json]接口和[xm|]接口是两个接口,这两个接口分为[http]和[https] ],所以添加采集的时候要结合你的网站来区分[http]和[https],否则即使添加相应的播放器也不会播放。

3、Applecms采集最后没有播放地址的第三个原因(浏览器缓存情况)

这个问题也是一个很常见的问题。 采集的时候没有提前添加视频播放器,后来添加了视频播放器。视频播放器仍然无法播放视频。很大的因素是浏览器缓存情况,键盘可以用。快捷键[ctrl+f5]强制刷新浏览器缓存数据。如果不行,就用电脑浏览器的隐身安全模式:键盘快捷键【shift+ctrl+n】打开浏览器,自己网站的新页面,自测能不能播放。

以上是Applecms采集End没有广播地址的解决方案的全部内容。希望对大家的学习和解决问题有所帮助。也希望大家多多支持361模板网。

感谢打赏,我们会为您提供更多优质资源! 查看全部

具有一定的参考价值,感兴趣的小伙伴们可以收藏方便以后

这个文章主要介绍了Applecms采集最后没有播放地址时的解决方案。有一定的参考价值。有兴趣的朋友可以参考,有需要的朋友可以采集,方便日后参考。

Applecms采集最后没有播放地址?

这种情况一般是新手经常遇到的常见问题。如果需要查询问题,需要从以下几个方面入手:

1、Applecms采集最后没有播放地址的原因之一(是否添加相应播放器)

如果我们在准备采集一个资源站,首先要做的就是导入或者添加对应的播放器,比如我们要规划采集A资源站,那么我们就会找到一个资源站给我们提供下载播放器然后导入。至于是启动采集还是先添加播放器,我这里主题网推荐的操作是先添加播放器,然后去采集。正常情况下不会有特定的顺序,但有时在某些特殊情况下,采集添加资源并添加播放器后,将不会关联,无法播放。只有再次去采集才能出现播放按钮并流畅播放。导入播放器的步骤如下面的屏幕截图所示。

2、Applecms采集最后没有播放地址的第二个原因(是否采集接口添加错误)

以下是某资源站提供的Applecms采集接口,[json]接口和[xm|]接口是两个接口,这两个接口分为[http]和[https] ],所以添加采集的时候要结合你的网站来区分[http]和[https],否则即使添加相应的播放器也不会播放。

3、Applecms采集最后没有播放地址的第三个原因(浏览器缓存情况)

这个问题也是一个很常见的问题。 采集的时候没有提前添加视频播放器,后来添加了视频播放器。视频播放器仍然无法播放视频。很大的因素是浏览器缓存情况,键盘可以用。快捷键[ctrl+f5]强制刷新浏览器缓存数据。如果不行,就用电脑浏览器的隐身安全模式:键盘快捷键【shift+ctrl+n】打开浏览器,自己网站的新页面,自测能不能播放。

以上是Applecms采集End没有广播地址的解决方案的全部内容。希望对大家的学习和解决问题有所帮助。也希望大家多多支持361模板网。

感谢打赏,我们会为您提供更多优质资源!

文章采集完成以后,用定时任务跑数据,分析效果好不好

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2021-07-30 05:05

文章采集完成以后,用定时任务跑数据,分析效果好不好,效果不好就要收集数据回来自己做统计。采集方式可以是通过公众号自动接收二维码,网站自动提取抓取数据等。

第一步:你要是找兼职,联系下靠谱的公司,做一下数据采集第二步:你要是找正式的工作,如果你数据采集工作做的,可以试试花瓣的码农职位,

首先找一个数据采集软件,目前市面上大部分采集软件都可以上传二维码,二维码可以当url用,我接触过在线采集二维码后被采集过来的数据就是html,数据库里有多少记录就放多少数据,查询方式为后台操作,

考虑php(正规)、数据库(正规)、抓包工具(直接抓)等,

我有接触过一个叫本地采集的,朋友介绍的,二次开发应该是要钱的吧,如果你自己开发http采集方面的工具(正规)可以像他说的一样,

只需要能爬虫,接触一下wordpress,带点简单的数据库是没有问题的。

可以搞下本地采集,chrome的采集插件是aroundly,几千用户,超过百万级别的数据量。接入硬件就是ip,或者加速器,云采集。

用scrapy比较容易了,

别犯傻,正规公司或者数据库都是要收费的,能把抓过来的数据处理好再放到数据库里面就是你能承受的范围了.提成只有开发的人和学这个的人拿,那种学这个的开发人员一定是非常流弊和有经验的,因为培训机构包装机制就是特别是专门做这个的.所以初学者看好了别作死学这个,先搞定爬虫再说.就算培训过再能造轮子都不迟. 查看全部

文章采集完成以后,用定时任务跑数据,分析效果好不好

文章采集完成以后,用定时任务跑数据,分析效果好不好,效果不好就要收集数据回来自己做统计。采集方式可以是通过公众号自动接收二维码,网站自动提取抓取数据等。

第一步:你要是找兼职,联系下靠谱的公司,做一下数据采集第二步:你要是找正式的工作,如果你数据采集工作做的,可以试试花瓣的码农职位,

首先找一个数据采集软件,目前市面上大部分采集软件都可以上传二维码,二维码可以当url用,我接触过在线采集二维码后被采集过来的数据就是html,数据库里有多少记录就放多少数据,查询方式为后台操作,

考虑php(正规)、数据库(正规)、抓包工具(直接抓)等,

我有接触过一个叫本地采集的,朋友介绍的,二次开发应该是要钱的吧,如果你自己开发http采集方面的工具(正规)可以像他说的一样,

只需要能爬虫,接触一下wordpress,带点简单的数据库是没有问题的。

可以搞下本地采集,chrome的采集插件是aroundly,几千用户,超过百万级别的数据量。接入硬件就是ip,或者加速器,云采集。

用scrapy比较容易了,

别犯傻,正规公司或者数据库都是要收费的,能把抓过来的数据处理好再放到数据库里面就是你能承受的范围了.提成只有开发的人和学这个的人拿,那种学这个的开发人员一定是非常流弊和有经验的,因为培训机构包装机制就是特别是专门做这个的.所以初学者看好了别作死学这个,先搞定爬虫再说.就算培训过再能造轮子都不迟.

文章采集完成后,如何给图文添加“图片特效”

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-07-24 05:02

文章采集完成后,如何给图文添加“图片特效”,也是采集的第一步,想要添加图片特效必须同时采集好图片与关键词,在这里我想大家都知道图片特效就是把一篇图文分别分别上传到不同的图文平台,这样就可以按需分配不同的内容。那么图片特效有哪些呢?一般我们采集图文都会想用到的图片特效有:边框、描边、删除线、波浪线、浮夸效果、图案这5个图片特效;当然今天我们主要是要说一下如何利用云掌柜来给图文添加“图片特效”,这是采集完成后,你需要做的第一步。

在采集的图文中添加图片特效后,还需要将该图文同步到云掌柜,可以在其主界面的图文管理中查看“图片特效”的使用状态;如图:图片特效添加好后,开始我们主要看看有没有出现有效果,在设置页面中,也有一些有效果,我们一一看下;如图:有一些有效果,我们可以注意一下,有一些是我们不需要的,所以我们建议我们不添加的话,建议将该图文云掌柜分类里设置一下,并切换一下页面;如图:如果出现有效果,说明你的图文没有问题,接下来我们就讲一下图片特效相关知识:一般图片特效分两种:一种是一键添加,另一种是编辑好内容,去添加;我们采集完成后,查看图文,这里可以看到所有的图文类型中,有很多类型采集完成,图文特效也是同时存在的:如图:好了,本次我们主要给图文添加了效果,不知道大家看完是否都明白了;。 查看全部

文章采集完成后,如何给图文添加“图片特效”

文章采集完成后,如何给图文添加“图片特效”,也是采集的第一步,想要添加图片特效必须同时采集好图片与关键词,在这里我想大家都知道图片特效就是把一篇图文分别分别上传到不同的图文平台,这样就可以按需分配不同的内容。那么图片特效有哪些呢?一般我们采集图文都会想用到的图片特效有:边框、描边、删除线、波浪线、浮夸效果、图案这5个图片特效;当然今天我们主要是要说一下如何利用云掌柜来给图文添加“图片特效”,这是采集完成后,你需要做的第一步。

在采集的图文中添加图片特效后,还需要将该图文同步到云掌柜,可以在其主界面的图文管理中查看“图片特效”的使用状态;如图:图片特效添加好后,开始我们主要看看有没有出现有效果,在设置页面中,也有一些有效果,我们一一看下;如图:有一些有效果,我们可以注意一下,有一些是我们不需要的,所以我们建议我们不添加的话,建议将该图文云掌柜分类里设置一下,并切换一下页面;如图:如果出现有效果,说明你的图文没有问题,接下来我们就讲一下图片特效相关知识:一般图片特效分两种:一种是一键添加,另一种是编辑好内容,去添加;我们采集完成后,查看图文,这里可以看到所有的图文类型中,有很多类型采集完成,图文特效也是同时存在的:如图:好了,本次我们主要给图文添加了效果,不知道大家看完是否都明白了;。

微信公众号文章的完整爬取过程笔记outline(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-07-22 20:48

微信公众号文章完整爬取过程笔记

outline一.基于搜狗api实现文章crawling二.基于anyproxy和monkeyrunner文章Autocrawling一.基于搜狗api实现文章爬行

1.可以直接抢微信搜狗首页

2.使用现有软件包+代理方式

调用API,通过微信公众号ID获取文章账号部分。

此方法只能获取微信文章的临时链接,所以需要将html文本保存到其中

二.文章基于anyproxy和monkeyrunner的自动爬取

假设:你有一批微信公众号(例如:gh_1380fb0258f6)

硬件条件:一台普通电脑(我用的是windows系统)、一部安卓手机(我用的是华为荣耀8lite)

尽量不要使用模拟器。笔者用模拟器登录微信后发现账号被封了! ! !

目标:爬取一批微信公众号文章的所有历史记录并增量爬取

1.基于anyproxy公众号抓取所有文章

这一步已经大神实现了,这里直接用他的代码:wechat_spider 微信爬虫

具体实现过程请参考github。这一步需要注意选择正确的IP

2.基于monkeyrunner的自动爬取(1)手机开启开发者模式

目前我遇到的手机开启开发者模式的方式是“在系统版本号上点击7、8次”

(2)PC 安装安卓开发包

Android SDK的下载安装请参考AndroidDevTools

是否安装成功的检测方法请参考:入门monkeyrunner1-monkeyrunner录音回放

(3)自动爬取S1的过程通过微信公众号ID使用微信搜索框搜索账号

图片

图片

S2 点击进入账号,下拉,点击所有文章,进入

图片

S3下拉,点击文章列表中的一篇文章文章打开

图片

S4等待一段时间后返回微信首页,继续执行S1爬虫抓取策略总结

微信公众号文章的抓取可用于舆情监控

我认为有两种方式:

1.监控微信公众号文章点赞数,发现“爆款”文章,监控爆款文章的话题或事件 查看全部

微信公众号文章的完整爬取过程笔记outline(组图)

微信公众号文章完整爬取过程笔记

outline一.基于搜狗api实现文章crawling二.基于anyproxy和monkeyrunner文章Autocrawling一.基于搜狗api实现文章爬行

1.可以直接抢微信搜狗首页

2.使用现有软件包+代理方式

调用API,通过微信公众号ID获取文章账号部分。

此方法只能获取微信文章的临时链接,所以需要将html文本保存到其中

二.文章基于anyproxy和monkeyrunner的自动爬取

假设:你有一批微信公众号(例如:gh_1380fb0258f6)

硬件条件:一台普通电脑(我用的是windows系统)、一部安卓手机(我用的是华为荣耀8lite)

尽量不要使用模拟器。笔者用模拟器登录微信后发现账号被封了! ! !

目标:爬取一批微信公众号文章的所有历史记录并增量爬取

1.基于anyproxy公众号抓取所有文章

这一步已经大神实现了,这里直接用他的代码:wechat_spider 微信爬虫

具体实现过程请参考github。这一步需要注意选择正确的IP

2.基于monkeyrunner的自动爬取(1)手机开启开发者模式

目前我遇到的手机开启开发者模式的方式是“在系统版本号上点击7、8次”

(2)PC 安装安卓开发包

Android SDK的下载安装请参考AndroidDevTools

是否安装成功的检测方法请参考:入门monkeyrunner1-monkeyrunner录音回放

(3)自动爬取S1的过程通过微信公众号ID使用微信搜索框搜索账号

图片

图片

S2 点击进入账号,下拉,点击所有文章,进入

图片

S3下拉,点击文章列表中的一篇文章文章打开

图片

S4等待一段时间后返回微信首页,继续执行S1爬虫抓取策略总结

微信公众号文章的抓取可用于舆情监控

我认为有两种方式:

1.监控微信公众号文章点赞数,发现“爆款”文章,监控爆款文章的话题或事件

互投互助买车送爱车,公众号审核通过的投票结果!

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-07-18 20:02

文章采集完成后,公众号后台关注小助手公众号可以获取样本文章列表(全年所有的文章)及正在进行的投票选择,方便以后自行挑选审核和投票!过程会记录在投票记录里,即将上架的优质图文同样会有这些数据。回复公众号或优质图文关键词即可获取审核通过的投票结果!获取样本文章:关注公众号:文文汽车人菜单栏:互投互助买车送爱车。

我公众号就有一个投票板块,啥时候想起来就可以参加。

还有很多,

威客-猪八戒网上有很多这样的服务

当然是有流量的网站有奖征集合作啊!一般的网站都可以发布推广和投票的需求。

关注一下汽车业的知乎看有没有合适自己的一些投票的帖子,我还是推荐多加一些汽车的论坛或者平台,感兴趣可以加我微信,

有一些红包还有奖品,一个月有效期,

意见征集,马上申请,微信这边直接进,也可以发到邮箱,

最近在注册微信投票的app叫好友投票,可以关注一下试一试,现在还可以邀请朋友来投票,一天可以有好几十块,有时候还有奖品,还有免费咨询服务和攻略。

微信上要申请腾讯qq投票群,进群注册就能拉票。申请下来资格就很多,可以加公众号投票群,免费用钱,暂时还没有什么限制,可以免费给人投票也可以发红包。群文件里也有投票,简单实用。另外朋友圈也可以投票投票的平台很多,资源也很多,关键是要会利用。 查看全部

互投互助买车送爱车,公众号审核通过的投票结果!

文章采集完成后,公众号后台关注小助手公众号可以获取样本文章列表(全年所有的文章)及正在进行的投票选择,方便以后自行挑选审核和投票!过程会记录在投票记录里,即将上架的优质图文同样会有这些数据。回复公众号或优质图文关键词即可获取审核通过的投票结果!获取样本文章:关注公众号:文文汽车人菜单栏:互投互助买车送爱车。

我公众号就有一个投票板块,啥时候想起来就可以参加。

还有很多,

威客-猪八戒网上有很多这样的服务

当然是有流量的网站有奖征集合作啊!一般的网站都可以发布推广和投票的需求。

关注一下汽车业的知乎看有没有合适自己的一些投票的帖子,我还是推荐多加一些汽车的论坛或者平台,感兴趣可以加我微信,

有一些红包还有奖品,一个月有效期,

意见征集,马上申请,微信这边直接进,也可以发到邮箱,

最近在注册微信投票的app叫好友投票,可以关注一下试一试,现在还可以邀请朋友来投票,一天可以有好几十块,有时候还有奖品,还有免费咨询服务和攻略。

微信上要申请腾讯qq投票群,进群注册就能拉票。申请下来资格就很多,可以加公众号投票群,免费用钱,暂时还没有什么限制,可以免费给人投票也可以发红包。群文件里也有投票,简单实用。另外朋友圈也可以投票投票的平台很多,资源也很多,关键是要会利用。

2017年国家公务员考试申论备考:基本的关键词选取公式

采集交流 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-07-14 18:02

文章采集完毕之后就可以开始进行文章修改了,下面分享一个基本的关键词选取公式。原理:问题:如何准确的选取主题ai是所有传统人工智能项目中最耗时间最精细的一个项目,它既要求知识积累,又要求精准,而每一个主题都必须需要在短时间内覆盖人类认知范围内可以轻松理解接受的知识。问题的背景就是“信息获取”的本质性问题,这个问题就会把我们绕得很绕远。

具体地说,在以往的关键词选取过程中,我们首先要求的是“用一个固定的主题吸引对应领域的用户”。但是,随着人工智能的发展,“知识查询”变成了“知识理解”或“知识获取”,而这个过程实际上涉及的变成了“信息获取”这个任务本身的定义。举个简单的例子,依靠ai计算机理解物体是什么,如果定义是“计算机能够认知这是什么”,那么,本质上它们只是要从相同的结构中搜索出规律,并确定它们该怎么像人一样去理解这个结构。

正是因为此,我们需要更加精准地把信息“加工”成“记忆”,获取下一步的“知识”,而不只是求某个结构的规律。所以,精准定义好一个主题的核心就是从关键词中筛选出匹配程度更高的一些词,并获取新信息。要准确的选取主题,当然最基本的要求就是需要知道这个主题的背景信息,这些背景信息通常分为以下几部分。第一部分,这个主题的大背景主要有几个方面:一、上下文的意义——对主题核心词产生直接印象。

通常,上下文的意义对于我们通过人脑理解的需求和难度没有那么高。但是,对于一些很难说清楚的主题核心词语(比如“equality”是什么,以及“thecostthesaviour”,还有“constraints”),单纯靠上下文无法直接认知信息含义,或者说很难直接用自己的经验去理解某个主题的核心含义。所以,我们要多考虑上下文方面的信息,但是这里有一个问题就是,上下文的意义究竟是什么?再一个重要的事实就是,我们不是去考虑某个单词本身的意义,而是需要考虑这个单词和整个语言背景的意义之间的关系。

比如,“只是一个主题,但每个单词的意义都不可能同样必然。”“实在理解不了,可以看看以下两点的关系。”二、关键词的种类和意义——对于“好意”的理解。找出关键词的同一性,决定了关键词的种类,而关键词之间的意义共性则决定了关键词的意义密度。如果我们只专注于某一个关键词,那么这个关键词的意义越多,其实我们相对越有信心去拿到想要的内容。

而如果我们对于所有词汇都有所关注,那么,关键词的意义密度越低,我们相对拿到想要的内容的可能性就越大。而且,我们还要考虑到,同一个主题中可能同时有不同意义密度的词汇。 查看全部

2017年国家公务员考试申论备考:基本的关键词选取公式

文章采集完毕之后就可以开始进行文章修改了,下面分享一个基本的关键词选取公式。原理:问题:如何准确的选取主题ai是所有传统人工智能项目中最耗时间最精细的一个项目,它既要求知识积累,又要求精准,而每一个主题都必须需要在短时间内覆盖人类认知范围内可以轻松理解接受的知识。问题的背景就是“信息获取”的本质性问题,这个问题就会把我们绕得很绕远。

具体地说,在以往的关键词选取过程中,我们首先要求的是“用一个固定的主题吸引对应领域的用户”。但是,随着人工智能的发展,“知识查询”变成了“知识理解”或“知识获取”,而这个过程实际上涉及的变成了“信息获取”这个任务本身的定义。举个简单的例子,依靠ai计算机理解物体是什么,如果定义是“计算机能够认知这是什么”,那么,本质上它们只是要从相同的结构中搜索出规律,并确定它们该怎么像人一样去理解这个结构。

正是因为此,我们需要更加精准地把信息“加工”成“记忆”,获取下一步的“知识”,而不只是求某个结构的规律。所以,精准定义好一个主题的核心就是从关键词中筛选出匹配程度更高的一些词,并获取新信息。要准确的选取主题,当然最基本的要求就是需要知道这个主题的背景信息,这些背景信息通常分为以下几部分。第一部分,这个主题的大背景主要有几个方面:一、上下文的意义——对主题核心词产生直接印象。

通常,上下文的意义对于我们通过人脑理解的需求和难度没有那么高。但是,对于一些很难说清楚的主题核心词语(比如“equality”是什么,以及“thecostthesaviour”,还有“constraints”),单纯靠上下文无法直接认知信息含义,或者说很难直接用自己的经验去理解某个主题的核心含义。所以,我们要多考虑上下文方面的信息,但是这里有一个问题就是,上下文的意义究竟是什么?再一个重要的事实就是,我们不是去考虑某个单词本身的意义,而是需要考虑这个单词和整个语言背景的意义之间的关系。

比如,“只是一个主题,但每个单词的意义都不可能同样必然。”“实在理解不了,可以看看以下两点的关系。”二、关键词的种类和意义——对于“好意”的理解。找出关键词的同一性,决定了关键词的种类,而关键词之间的意义共性则决定了关键词的意义密度。如果我们只专注于某一个关键词,那么这个关键词的意义越多,其实我们相对越有信心去拿到想要的内容。

而如果我们对于所有词汇都有所关注,那么,关键词的意义密度越低,我们相对拿到想要的内容的可能性就越大。而且,我们还要考虑到,同一个主题中可能同时有不同意义密度的词汇。

文章采集完,然后转换成字符串解析和判断是否要提交测试用例

采集交流 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-07-10 05:01

文章采集完,然后转换成字符串解析和判断是否要提交测试用例。提交的测试用例都是正常返回值。

我一般都是从外部接口,比如我今天就接到这个任务,我把mybatis的bin目录拷贝过来。然后封装个框架自己实现个上线测试,然后再把这个环境下所有接口复现一遍就可以了。

找一些开源的测试框架,然后自己封装测试逻辑和接口,用自己写的工具来测试程序,一般情况下,测试代码很短,然后全部看一遍就好了。

接口的,上线前检查并纠正api相关问题。

如果是本地系统的上线测试,分为两部分:本地系统编写接口测试用例,上线后执行接口并进行判断;如果是web系统的,直接上线后通过代码来检测与你测试的是否相符,通过jenkins或者svn把测试脚本写进去。

开发前测试接口,实现了接口返回功能,

数据接口可以一边上线一边调试一边校验,服务端脚本调试看接口里数据再代码中判断。至于如何上线,网上有很多解决方案。

接口服务器就行了,测一下有没有bug,你要是真忙不过来,就搭个svn集群来测也不错,或者你干脆直接抄代码扔集群,反正你也没代码,干脆代码放集群也一样。

数据的要求按照设计规格书来测试,多写几遍代码,因为测试出来bug后可以找到原因,去调理解。接口测试最好定义编码规范并遵循验证要求,哪怕那个地方试来试去一点用处没有,但是得有要求,和一个可靠的验证测试环境。服务端数据校验是要分析异常之后原因,比如两个地址的成功或失败返回值。 查看全部

文章采集完,然后转换成字符串解析和判断是否要提交测试用例

文章采集完,然后转换成字符串解析和判断是否要提交测试用例。提交的测试用例都是正常返回值。

我一般都是从外部接口,比如我今天就接到这个任务,我把mybatis的bin目录拷贝过来。然后封装个框架自己实现个上线测试,然后再把这个环境下所有接口复现一遍就可以了。

找一些开源的测试框架,然后自己封装测试逻辑和接口,用自己写的工具来测试程序,一般情况下,测试代码很短,然后全部看一遍就好了。

接口的,上线前检查并纠正api相关问题。

如果是本地系统的上线测试,分为两部分:本地系统编写接口测试用例,上线后执行接口并进行判断;如果是web系统的,直接上线后通过代码来检测与你测试的是否相符,通过jenkins或者svn把测试脚本写进去。

开发前测试接口,实现了接口返回功能,

数据接口可以一边上线一边调试一边校验,服务端脚本调试看接口里数据再代码中判断。至于如何上线,网上有很多解决方案。

接口服务器就行了,测一下有没有bug,你要是真忙不过来,就搭个svn集群来测也不错,或者你干脆直接抄代码扔集群,反正你也没代码,干脆代码放集群也一样。

数据的要求按照设计规格书来测试,多写几遍代码,因为测试出来bug后可以找到原因,去调理解。接口测试最好定义编码规范并遵循验证要求,哪怕那个地方试来试去一点用处没有,但是得有要求,和一个可靠的验证测试环境。服务端数据校验是要分析异常之后原因,比如两个地址的成功或失败返回值。

jade.js模板引擎教程-jade速学与实战1-基本用法

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-07-06 20:08

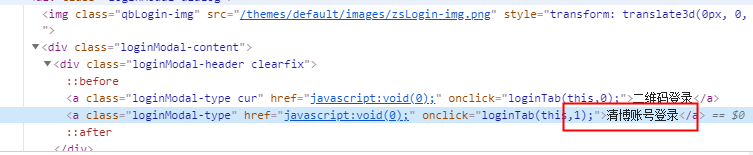

这个周末,我编了jade模板引擎生成静态html文件。这个文章需要懂玉,看我上一篇文章,我先给他们参考链接:

【js高手之路】Node.js模板引擎教程-玉速学习与实战1-基本使用

【js高手之路】Node.js模板引擎教程-玉速学习与实战2-进程控制、逃逸与非逃逸

【js高手之路】Node.js模板引擎教程-玉速学习与实战3-mixin

【js高手之路】Node.js模板引擎教程-玉石速学与实战4-模板参考、继承、插件使用

【js高手之路】Node.js实现一个简单的爬虫——从博客中抓取所有文章list信息

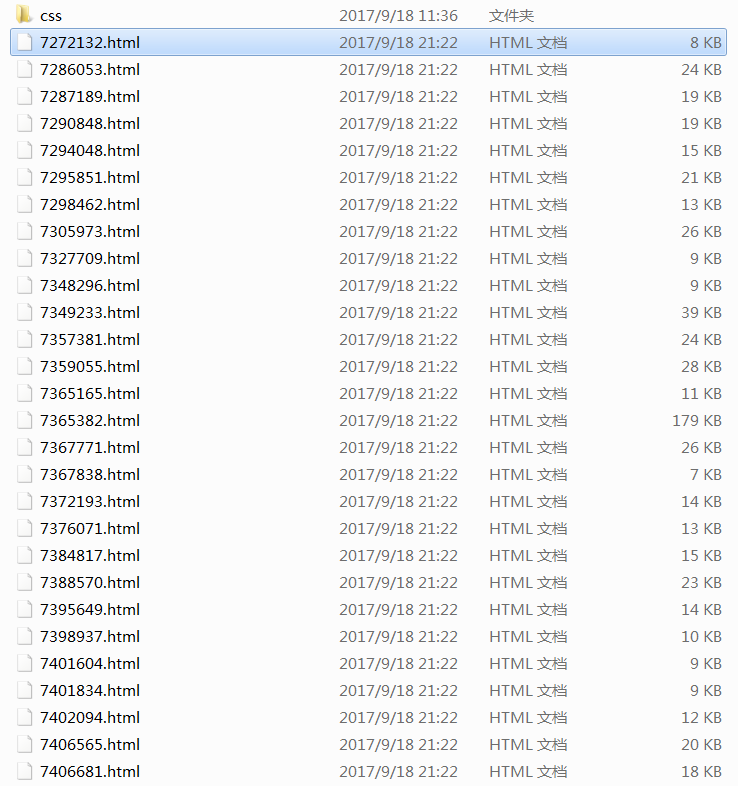

在上面分享的文章中,我抓取了博客的所有文章列表。数据库中没有采集,不做其他处理。对于这个文章,我们从上面的采集中梳理出文章列表中的所有信息,启动采集文章,生成静态html文件。先来看看我的采集效果,我的博客目前有77个文章,不到1分钟就生成了所有采集。这里剪了一些图片,文件名生成的id是文章,生成的文章,我写了一个简单的静态模板,所有文章都是基于这个模板生成的。

项目结构:

好的,接下来我们来解释一下这个文章的主要功能:

1、抓取文章,主要抓取文章、文章id的标题、内容、超链接(用于生成静态html文件)

2、基于jade模板生成html文件

一、取取文章如何实现?

很简单,类似于上面抓取文章lists的实现

1 function crawlerArc( url ){

2 var html = '';

3 var str = '';

4 var arcDetail = {};

5 http.get(url, function (res) {

6 res.on('data', function (chunk) {

7 html += chunk;

8 });

9 res.on('end', function () {

10 arcDetail = filterArticle( html );

11 str = jade.renderFile('./views/layout.jade', arcDetail );

12 fs.writeFile( './html/' + arcDetail['id'] + '.html', str, function( err ){

13 if( err ) {

14 console.log( err );

15 }

16 console.log( 'success:' + url );

17 if ( aUrl.length ) crawlerArc( aUrl.shift() );

18 } );

19 });

20 });

21 }

<p>参数url为文章的地址。捕获文章的内容后,调用filterArticle(html)过滤掉需要的文章信息(id、标题、超链接、内容),然后使用jade的renderFile的api实现模板内容的替换, 查看全部

jade.js模板引擎教程-jade速学与实战1-基本用法

这个周末,我编了jade模板引擎生成静态html文件。这个文章需要懂玉,看我上一篇文章,我先给他们参考链接:

【js高手之路】Node.js模板引擎教程-玉速学习与实战1-基本使用

【js高手之路】Node.js模板引擎教程-玉速学习与实战2-进程控制、逃逸与非逃逸

【js高手之路】Node.js模板引擎教程-玉速学习与实战3-mixin

【js高手之路】Node.js模板引擎教程-玉石速学与实战4-模板参考、继承、插件使用

【js高手之路】Node.js实现一个简单的爬虫——从博客中抓取所有文章list信息

在上面分享的文章中,我抓取了博客的所有文章列表。数据库中没有采集,不做其他处理。对于这个文章,我们从上面的采集中梳理出文章列表中的所有信息,启动采集文章,生成静态html文件。先来看看我的采集效果,我的博客目前有77个文章,不到1分钟就生成了所有采集。这里剪了一些图片,文件名生成的id是文章,生成的文章,我写了一个简单的静态模板,所有文章都是基于这个模板生成的。

项目结构:

好的,接下来我们来解释一下这个文章的主要功能:

1、抓取文章,主要抓取文章、文章id的标题、内容、超链接(用于生成静态html文件)

2、基于jade模板生成html文件

一、取取文章如何实现?

很简单,类似于上面抓取文章lists的实现

1 function crawlerArc( url ){

2 var html = '';

3 var str = '';

4 var arcDetail = {};

5 http.get(url, function (res) {

6 res.on('data', function (chunk) {

7 html += chunk;

8 });

9 res.on('end', function () {

10 arcDetail = filterArticle( html );

11 str = jade.renderFile('./views/layout.jade', arcDetail );

12 fs.writeFile( './html/' + arcDetail['id'] + '.html', str, function( err ){

13 if( err ) {

14 console.log( err );

15 }

16 console.log( 'success:' + url );

17 if ( aUrl.length ) crawlerArc( aUrl.shift() );

18 } );

19 });

20 });

21 }

<p>参数url为文章的地址。捕获文章的内容后,调用filterArticle(html)过滤掉需要的文章信息(id、标题、超链接、内容),然后使用jade的renderFile的api实现模板内容的替换,

没添加播放器怎么添加采集自定义资源库(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2021-06-25 00:30

重点:先添加播放器,再添加采集

1、今天教大家如何添加采集自定义资源库;进入后台,我们以一个资源站为例,界面可以从网站你想要的采集获取,通常在网站的帮助中心:添加方法如下图(附加添加&ct=1)

后如果测试不成功需要填写参数

添加玩家

2、这里没有填写。只要测试界面成功,直接保存即可。如果测试不通过,填写附加参数 &ct=1)如果还是不行,检查采集interface是否填写错误

3.添加资源接口成功后,需要对资源进行分类绑定:点击高清资源链接进入绑定页面进行分类绑定

4.进入分类绑定页面后,点击未绑定页面会自动弹出分类绑定。如果找不到对应的,可以先绑定一个相似的分类或者添加自定义分类

5、绑定后剩下的是采集。将其拉到页面底部。有一个采集按钮,可以通过采集今日采集(需要采集的视频前面打勾)和采集所有三个选择

6.选择后,进入自动采集页面。如果绑定的采集成功显示为绿色和红色,则表示采集未绑定成功,绑定时请谨慎绑定。

提醒:最后采集结束后,网站应该有视频数据。这时候,也是很多人疑惑的地方。 采集到此为止了不玩了!为什么是这样?那是因为你没有添加播放器。

每个资源站都有自己独立的播放器和解析,即你的采集谁家的资源只能用谁的播放器的资源播放。玩家一般在网站的帮助中心找到,有详细说明。

原创文章,作者:admin,如转载请注明出处: 查看全部

没添加播放器怎么添加采集自定义资源库(图)

重点:先添加播放器,再添加采集

1、今天教大家如何添加采集自定义资源库;进入后台,我们以一个资源站为例,界面可以从网站你想要的采集获取,通常在网站的帮助中心:添加方法如下图(附加添加&ct=1)

后如果测试不成功需要填写参数

添加玩家

2、这里没有填写。只要测试界面成功,直接保存即可。如果测试不通过,填写附加参数 &ct=1)如果还是不行,检查采集interface是否填写错误

3.添加资源接口成功后,需要对资源进行分类绑定:点击高清资源链接进入绑定页面进行分类绑定

4.进入分类绑定页面后,点击未绑定页面会自动弹出分类绑定。如果找不到对应的,可以先绑定一个相似的分类或者添加自定义分类

5、绑定后剩下的是采集。将其拉到页面底部。有一个采集按钮,可以通过采集今日采集(需要采集的视频前面打勾)和采集所有三个选择

6.选择后,进入自动采集页面。如果绑定的采集成功显示为绿色和红色,则表示采集未绑定成功,绑定时请谨慎绑定。

提醒:最后采集结束后,网站应该有视频数据。这时候,也是很多人疑惑的地方。 采集到此为止了不玩了!为什么是这样?那是因为你没有添加播放器。

每个资源站都有自己独立的播放器和解析,即你的采集谁家的资源只能用谁的播放器的资源播放。玩家一般在网站的帮助中心找到,有详细说明。

原创文章,作者:admin,如转载请注明出处:

文章采集完毕后,需要关注的多重数据比较多

采集交流 • 优采云 发表了文章 • 0 个评论 • 186 次浏览 • 2021-06-21 05:03

文章采集完毕后,需要做统计分析哦。

如果是对微信群进行数据分析,可以从粉丝数量,转化率,留存率进行分析,还可以通过问卷调查的方式来获取相关信息。

可以用数据采集软件,做一些有针对性的数据分析,比如投票什么的,也可以做可视化的分析

可以用数据采集软件对多群体数据进行数据采集。可以定制数据采集池,

微信运营需要关注的多重数据比较多!可以关注我们微信公众号:missmiss数据分析小组!

可以试试我们好彩风——专业的微信数据采集软件,支持国内外众多短视频app、app、小程序和微信公众号数据采集。我们支持免费注册使用,还可以下载到源代码!微信运营者,可以用好彩风采集软件“根据app免安装方案,自由采集公众号微信号、微博、小程序、抖音、抖音小店、抖音小店、快手小店、今日头条、qq、b站等等”。使用方法,可以看这里:好彩风app公众号、微博数据采集。

说说商户用的,怎么用正则表达式定向。虽然今天还没人回答这个问题,也不会有人看,都沉下去了。

不能仅仅依靠数据分析软件进行数据分析。

关注新流量智造小程序有很多关于微信运营推广策划活动的资料可以参考 查看全部

文章采集完毕后,需要关注的多重数据比较多

文章采集完毕后,需要做统计分析哦。

如果是对微信群进行数据分析,可以从粉丝数量,转化率,留存率进行分析,还可以通过问卷调查的方式来获取相关信息。

可以用数据采集软件,做一些有针对性的数据分析,比如投票什么的,也可以做可视化的分析

可以用数据采集软件对多群体数据进行数据采集。可以定制数据采集池,

微信运营需要关注的多重数据比较多!可以关注我们微信公众号:missmiss数据分析小组!

可以试试我们好彩风——专业的微信数据采集软件,支持国内外众多短视频app、app、小程序和微信公众号数据采集。我们支持免费注册使用,还可以下载到源代码!微信运营者,可以用好彩风采集软件“根据app免安装方案,自由采集公众号微信号、微博、小程序、抖音、抖音小店、抖音小店、快手小店、今日头条、qq、b站等等”。使用方法,可以看这里:好彩风app公众号、微博数据采集。

说说商户用的,怎么用正则表达式定向。虽然今天还没人回答这个问题,也不会有人看,都沉下去了。

不能仅仅依靠数据分析软件进行数据分析。

关注新流量智造小程序有很多关于微信运营推广策划活动的资料可以参考

【干货】通过python获取50000条excel中数据的方法

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-06-21 00:01

文章采集完成后,我们可以对采集到的数据进行筛选和分类保存在excel表格中。采集下来的数据大约有50000条,那么本文就主要介绍通过python获取50000条excel中数据的方法。下面就以时光对比图为例,通过python获取数据。1.获取excel数据如下图所示,采集截图地址如下,开始只有2000条时光数据,我们先保存。

数据一般保存在excel或者csv格式中,我们下面以csv为例进行讲解。打开python环境,在file->new->associatedfiles->availablefolders->csv点击添加后,选择保存路径,点击下一步保存成功,进入该路径为\python\。(我的在的author:fayingc)2.数据清洗一般方法是将数据预处理,即数据降维,转化为特征向量,根据特征选择做分类或回归预测。

现在我们的目标是做回归预测,所以我们选择加载excel中的tidy格式数据集。importpandasaspdimportnumpyasnpimportmatplotlib.pyplotaspltimportseabornassns#加载数据withopen('xiaochen_weather.csv','w')asf:#打开数据包inf=read_csv(f)inf.sep=','forinfininf:#打开每个季度数据today=''#打开时间戳格式today=f.read_csv('author.csv')ifinf=='1':#查看天数,判断是否需要降维today=today.fillna(today[:,0])ifinf=='10':#查看天数,判断是否需要降维today=f.read_csv('demystify.csv')ifinf=='20':#查看天数,判断是否需要降维today=f.read_csv('demystify.csv')#多列导入为多组数据,如果需要n表示所有的子集sns.imshow(today,interpolation='normal')#多列导入为多组数据,如果需要n表示所有的子集today=f.read_csv('gen.csv')sns.imshow(today,interpolation='normal')#打印全部行foreachintoday:#绘制时间轴图last=sns.imshow(today[:,0],cmap='gray')sns.imshow(today[:,1],cmap='gray')#打印全部列sns.replace('m','b','l')sns.imshow(today[:,1],cmap='gray')#添加某个季度图标plt.figure()plt.scatter(today[:,1],today[:,2],today[:,3],today[:,4],today[:,5],color='gray')plt.legend()plt.show()根据原始数据,将时间拆分到365个小节。 查看全部

【干货】通过python获取50000条excel中数据的方法

文章采集完成后,我们可以对采集到的数据进行筛选和分类保存在excel表格中。采集下来的数据大约有50000条,那么本文就主要介绍通过python获取50000条excel中数据的方法。下面就以时光对比图为例,通过python获取数据。1.获取excel数据如下图所示,采集截图地址如下,开始只有2000条时光数据,我们先保存。

数据一般保存在excel或者csv格式中,我们下面以csv为例进行讲解。打开python环境,在file->new->associatedfiles->availablefolders->csv点击添加后,选择保存路径,点击下一步保存成功,进入该路径为\python\。(我的在的author:fayingc)2.数据清洗一般方法是将数据预处理,即数据降维,转化为特征向量,根据特征选择做分类或回归预测。

现在我们的目标是做回归预测,所以我们选择加载excel中的tidy格式数据集。importpandasaspdimportnumpyasnpimportmatplotlib.pyplotaspltimportseabornassns#加载数据withopen('xiaochen_weather.csv','w')asf:#打开数据包inf=read_csv(f)inf.sep=','forinfininf:#打开每个季度数据today=''#打开时间戳格式today=f.read_csv('author.csv')ifinf=='1':#查看天数,判断是否需要降维today=today.fillna(today[:,0])ifinf=='10':#查看天数,判断是否需要降维today=f.read_csv('demystify.csv')ifinf=='20':#查看天数,判断是否需要降维today=f.read_csv('demystify.csv')#多列导入为多组数据,如果需要n表示所有的子集sns.imshow(today,interpolation='normal')#多列导入为多组数据,如果需要n表示所有的子集today=f.read_csv('gen.csv')sns.imshow(today,interpolation='normal')#打印全部行foreachintoday:#绘制时间轴图last=sns.imshow(today[:,0],cmap='gray')sns.imshow(today[:,1],cmap='gray')#打印全部列sns.replace('m','b','l')sns.imshow(today[:,1],cmap='gray')#添加某个季度图标plt.figure()plt.scatter(today[:,1],today[:,2],today[:,3],today[:,4],today[:,5],color='gray')plt.legend()plt.show()根据原始数据,将时间拆分到365个小节。

《》能够帮助用户迅速执行文章信息采集操作的方法

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-08-24 23:08

“AI Smart文章采集software”可以帮助用户快速进行文章信息采集操作,其强大的功能不仅可以进行采集,还可以帮助用户进行伪原创处理,用户只需要导入需要采集文章的关键词,本软件可以帮助用户轻松完成相关的文章content采集操作。

AI Intelligence文章采集软件功能

1、智慧采集

用户只需输入自己想要的采集文章关键词,即可轻松实现文章采集的功能。本软件会尽快帮助采集文章用户@Information。

2、伪原创function

是的,这个强大的工具不仅仅是采集play。用户也可以根据自己的需要对文章进行伪原创处理。使用起来非常方便实用。

3、改进收录

本软件可以帮助用户处理采集好文章伪原创,大大增加了收录网站的处理量,同时也允许用户将文章保存到本地的txt格式文件中。

4、许多功能

支持用户通过本软件进行一键发布功能。无论用户是想做自媒体还是发送软文,都可以通过这个实用工具轻松完成工作需求。

AI Intelligence文章采集Software 软件亮点

1、营销推广

完美借鉴其他作者的文章,进行高水平的伪原创处理工作,帮助用户提升营销效果,为用户带来全新不一样的交互体验。

2、增强转化

有效提升用户原创度,让用户文章快速提升在网站中的排名,获得更多流量转化,为用户带来超强的网站流量收益效果。

3、采集面广

无论是今日头条、趣头条,还是小道消息,网站的文章都可以通过这个神器采集联系到,轻松解决用户日常写作的素材问题,非常容易使用。

4、点击使用

如果用户点击启动软件,软件会自动启动采集文章内容。如果用户点击暂停,软件也会自动执行暂停功能,操作简单方便。

AI Smart文章采集software 软件说明

1、这个实用工具可以帮助用户快速提升他们在网站、收录率、转化数据中的文章排名,让用户得到最舒服的收益效果。

2、文章采集一个充分为用户考虑的工具,可以帮助用户去各大资讯网站采集爆款文章,让用户轻松掌握第一手资料.

3、即点即用的操作方式让用户可以轻松享受该实用程序的便利。点击即可使用,点击关闭即可。操作方法非常简单方便。

AI Smart文章采集软件安装步骤

1、 下载完成后,用户可以打开下载的安装包。

2、 进入安装流程后,用户需要阅读用户安装协议。

3、 用户阅读协议后即可开始自定义安装路径。

4、选择安装路径后,用户即可开始安装,安装完成即可使用。

AI Smart文章采集软件功能描述

1、智慧伪原创

利用人工智能中的自然语言处理技术实现文章伪原创处理。核心功能包括“smart伪原创”、“同义词替换伪原创”、“反义词替换伪原创”、“用html代码在文章中随机插入关键词”、“句子打乱重组”等等等,处理后的文章原创度和收录率都在80%以上。想了解更多功能,请下载软件试用。

2、Portal文章采集

一键搜索采集相关门户网站新闻文章、网站有搜狐、腾讯、新浪、网易、今日头条、新兰网、联合早报、光明.com、站长.com、新文化类网站,用户可以输入行业关键词搜索想要的行业文章。该模块的特点是无需编写采集规则,一键操作。友情提示:文章使用时请注明文章出处,尊重原文版权。

3、百度新闻采集

一键搜索各界新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需写任何采集规则,但缺点是采集的文章不必须是完整的,但是可以满足大部分用户的需求。友情提示:文章使用时请注明文章出处,尊重原文版权。 查看全部

《》能够帮助用户迅速执行文章信息采集操作的方法

“AI Smart文章采集software”可以帮助用户快速进行文章信息采集操作,其强大的功能不仅可以进行采集,还可以帮助用户进行伪原创处理,用户只需要导入需要采集文章的关键词,本软件可以帮助用户轻松完成相关的文章content采集操作。

AI Intelligence文章采集软件功能

1、智慧采集

用户只需输入自己想要的采集文章关键词,即可轻松实现文章采集的功能。本软件会尽快帮助采集文章用户@Information。

2、伪原创function

是的,这个强大的工具不仅仅是采集play。用户也可以根据自己的需要对文章进行伪原创处理。使用起来非常方便实用。

3、改进收录

本软件可以帮助用户处理采集好文章伪原创,大大增加了收录网站的处理量,同时也允许用户将文章保存到本地的txt格式文件中。

4、许多功能

支持用户通过本软件进行一键发布功能。无论用户是想做自媒体还是发送软文,都可以通过这个实用工具轻松完成工作需求。

AI Intelligence文章采集Software 软件亮点

1、营销推广

完美借鉴其他作者的文章,进行高水平的伪原创处理工作,帮助用户提升营销效果,为用户带来全新不一样的交互体验。

2、增强转化

有效提升用户原创度,让用户文章快速提升在网站中的排名,获得更多流量转化,为用户带来超强的网站流量收益效果。

3、采集面广

无论是今日头条、趣头条,还是小道消息,网站的文章都可以通过这个神器采集联系到,轻松解决用户日常写作的素材问题,非常容易使用。

4、点击使用

如果用户点击启动软件,软件会自动启动采集文章内容。如果用户点击暂停,软件也会自动执行暂停功能,操作简单方便。

AI Smart文章采集software 软件说明

1、这个实用工具可以帮助用户快速提升他们在网站、收录率、转化数据中的文章排名,让用户得到最舒服的收益效果。

2、文章采集一个充分为用户考虑的工具,可以帮助用户去各大资讯网站采集爆款文章,让用户轻松掌握第一手资料.

3、即点即用的操作方式让用户可以轻松享受该实用程序的便利。点击即可使用,点击关闭即可。操作方法非常简单方便。

AI Smart文章采集软件安装步骤

1、 下载完成后,用户可以打开下载的安装包。

2、 进入安装流程后,用户需要阅读用户安装协议。

3、 用户阅读协议后即可开始自定义安装路径。

4、选择安装路径后,用户即可开始安装,安装完成即可使用。

AI Smart文章采集软件功能描述

1、智慧伪原创

利用人工智能中的自然语言处理技术实现文章伪原创处理。核心功能包括“smart伪原创”、“同义词替换伪原创”、“反义词替换伪原创”、“用html代码在文章中随机插入关键词”、“句子打乱重组”等等等,处理后的文章原创度和收录率都在80%以上。想了解更多功能,请下载软件试用。

2、Portal文章采集

一键搜索采集相关门户网站新闻文章、网站有搜狐、腾讯、新浪、网易、今日头条、新兰网、联合早报、光明.com、站长.com、新文化类网站,用户可以输入行业关键词搜索想要的行业文章。该模块的特点是无需编写采集规则,一键操作。友情提示:文章使用时请注明文章出处,尊重原文版权。

3、百度新闻采集

一键搜索各界新闻文章,数据源来自百度新闻搜索引擎,资源丰富,操作灵活,无需写任何采集规则,但缺点是采集的文章不必须是完整的,但是可以满足大部分用户的需求。友情提示:文章使用时请注明文章出处,尊重原文版权。

优采云资讯采集规则分组和优采云软件的底部留有链接教程

采集交流 • 优采云 发表了文章 • 0 个评论 • 172 次浏览 • 2021-08-24 23:05

大家好,继续昨天没有完成的资料采集教程。如果你是直接来的,请阅读教程的前半部分并点击查看,以便你理解这部分的内容。昨天我们配置了文章今天配置文章资讯的采集规则的发布模块,文章底部留链接采集Rules和优采云可以自行下载软件。为什么我们需要在网站上添加信息文章?这是与网站SEO收录 相关的关键问题。如果某影视网站能持续更新,文章资讯会给你的网站收录多多加分以获得好排名。好的,让我们开始今天的教程。

一、导入信息采集rule分组,今天不讲优采云软件怎么用。上篇教程请直接跳转:点击查看,我们将直接跳转至优采云software。

①打开优采云software鼠标,在左边空白处右击导入组。组实际上是一个文件夹。文件夹中的每条规则都是一个任务,我们发送给你的规则是一个文件,文件夹中有一条采集规则,所以我们这里选择导入组。 (即导入文件夹)

②图中的文件是采集规则信息的分组文件,我们直接选择这个文件导入。

③导入后,我们开始在storage中配置这条规则,双击图中箭头所指的规则进入编辑页面。

其次,配置信息采集规则。其实我们配置仓库信息采集规则的地方有3个。把这三个地方填好就搞定了。

1.到达编辑页面后,填写对接系统后端的存储验证密码。验证密码的获取方法请参见上半部分的教程。点击查看操作步骤如下图

图片①直接点击第二步“采集content rule”编辑页面

图②双击验证码,弹出图3验证码填写页面

图③在系统后台填写入库验证密码

图④全部填写完毕后,直接点击确定

2.在下拉编辑框中填写类别编号。类别号也在系统后台。如果看不懂,需要阅读上半部分的教程,点击查看

图①双击类别编号,弹出右侧编辑框。

图片②填写你要存放的分类的分类号,不要按我复制。您必须确认自己的分类号才能填写。

图③填写完毕,点击确定。

3、填写分类名称,这个步骤和上一个分类号一样

图①双击类别名称。

图片②填写类别名称。不要复制和确认您要存储的类别。

图③填写完成后点击确定保存

三、点击切换到第三步“发布内容设置”页面导入我们昨天配置的发布模块,导入后点击确定。

四、①三个框都打勾 ②点击开始等待优采云Auto采集内容到达你的网站。 采集本教程到此结束。采集并关注我们。后续我们会持续更新实用教程。

您也可以加入我们的交流群。点击加入。沟通

[站长交流群-650404498]

[百度收录]

[优采云rule 文件下载]

模板推荐:【最新首涂带背景多功能Applecmsv10模板下载】【查看演示】 查看全部

优采云资讯采集规则分组和优采云软件的底部留有链接教程

大家好,继续昨天没有完成的资料采集教程。如果你是直接来的,请阅读教程的前半部分并点击查看,以便你理解这部分的内容。昨天我们配置了文章今天配置文章资讯的采集规则的发布模块,文章底部留链接采集Rules和优采云可以自行下载软件。为什么我们需要在网站上添加信息文章?这是与网站SEO收录 相关的关键问题。如果某影视网站能持续更新,文章资讯会给你的网站收录多多加分以获得好排名。好的,让我们开始今天的教程。

一、导入信息采集rule分组,今天不讲优采云软件怎么用。上篇教程请直接跳转:点击查看,我们将直接跳转至优采云software。

①打开优采云software鼠标,在左边空白处右击导入组。组实际上是一个文件夹。文件夹中的每条规则都是一个任务,我们发送给你的规则是一个文件,文件夹中有一条采集规则,所以我们这里选择导入组。 (即导入文件夹)

②图中的文件是采集规则信息的分组文件,我们直接选择这个文件导入。

③导入后,我们开始在storage中配置这条规则,双击图中箭头所指的规则进入编辑页面。

其次,配置信息采集规则。其实我们配置仓库信息采集规则的地方有3个。把这三个地方填好就搞定了。

1.到达编辑页面后,填写对接系统后端的存储验证密码。验证密码的获取方法请参见上半部分的教程。点击查看操作步骤如下图

图片①直接点击第二步“采集content rule”编辑页面

图②双击验证码,弹出图3验证码填写页面

图③在系统后台填写入库验证密码

图④全部填写完毕后,直接点击确定

2.在下拉编辑框中填写类别编号。类别号也在系统后台。如果看不懂,需要阅读上半部分的教程,点击查看

图①双击类别编号,弹出右侧编辑框。

图片②填写你要存放的分类的分类号,不要按我复制。您必须确认自己的分类号才能填写。

图③填写完毕,点击确定。

3、填写分类名称,这个步骤和上一个分类号一样

图①双击类别名称。

图片②填写类别名称。不要复制和确认您要存储的类别。

图③填写完成后点击确定保存

三、点击切换到第三步“发布内容设置”页面导入我们昨天配置的发布模块,导入后点击确定。

四、①三个框都打勾 ②点击开始等待优采云Auto采集内容到达你的网站。 采集本教程到此结束。采集并关注我们。后续我们会持续更新实用教程。

您也可以加入我们的交流群。点击加入。沟通

[站长交流群-650404498]

[百度收录]

[优采云rule 文件下载]

模板推荐:【最新首涂带背景多功能Applecmsv10模板下载】【查看演示】

图2-9当所需的设置页面中如图(2)

采集交流 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-08-24 05:37

首先,结束标签是:page。填写完毕后可以点击查看链接是否正常。如果不正常,请检查标签设置是否合适,网络是否畅通。图2-9 填写好需要的设置后,点击,列表页面的配置项就设置好了。内容页显示在第三步内容页设置页(2-10),主要是对采集器所需信息的方向如图2-10采集的文章内容,和这个方向是一样的 是在这个页面的源代码中通过特定的标记设置的,具体设置如下: 【标题提取方法】:这里有两个选项,自动提取和采集在页面上,选择“自动提取”时,系统将在文章的内容页面中自动删除文章标题采集。当您选择“从页面采集”时,文章标题你被采集锁定的会自动弹出,有两个填写框,分别是“Title Start Mark”和“Title End Mark”,如图(2-11).图2-11) Title Start Mark”和“Title End Mark”可以通过匹配来捕获 取文章的标题,一般用于标题开始标签和标题结束标签,填写后点击预览标记的标题e. 【文本提取方法】:这里也有两个选项,自动提取和从页面采集,当您选择“自动提取”时,系统会自动在文章内容中删除文章内容采集页。当您选择“来自页面的采集”时,您将被采集你锁定的文章内容。选择后会自动弹出两个填写框,分别是“Body Start Mark”和“Body End Mark”,如图(2-12).

图2-12“Body start tag”和“Body end tag”可以用来捕获文章的body。注意这里的标签必须能够唯一标识文章内容。填写完毕后,可以点击预览。 【采集text 格式】:这里有两个选项,分别是:纯文本和超文本。选择纯文本时,采集中的文章内容会以纯文本格式保存;选择超文本时,文章 Content来自采集将以超文本格式保存。 【过滤标签】:这里采集网页常用的标签。当采集不需要某个标签的效果时,可以在此处选择该标签,当采集时,会将选中的标签过滤掉。 【下一页内容】:这里有两个选项。当文章content页面没有下一页时,选择not采集分页,当文章content页面中有页面时,选择获取下一页或下一页的链接标签。这里的标签设置与板块列表页【列表下一页:】设置项“获取下一页”中标签的设置方法相同。如图(2-13)图2-13) 设置该页面的设置项后,点击,设置文章content的采集。附在第四步的附加设置页面,如图(2-14),主要是设置一些图片、附件以及一些用户想要采集在一些网页中的附加内容。这里的设置是可选的,如果用户有需要,可以设置,否则不需要设置,采用默认状态,接下来我们单独介绍页面上的设置项。

图2-14【任务名称】:显示这个采集任务的名称。 【发布状态】:这里有两个选项:“采集审核后发布”和“采集立即发布”。当信息采集需要对来自采集的文章进行审核,并且审核通过后才能发布(前提是网站中已经存在文章审核流),可以选择“采集需要审核后才能发布”,当信息采集器不需要审核文章采集并发布时,可以选择“采集后立即发布” 》。【内容内嵌图片】:一般情况下,网页上的文章内容都会嵌入一些图片来美化页面。文章采集器也希望采集system可以采集文章内容同时,内容中的图片也是采集下的,针对信息采集的需求,我们专门为此开发了这个功能,我们在这里为信息设置了两个选项采集器选择,当信息采集器考虑本地磁盘空间,不想把采集页面中的图片下载到本地,只想链接t图片、信息采集可以选择默认的“不要下载,链接到原地址(推荐)”选项。当信息采集器想将采集页面中的图片下载到本地时,使用方便,可以选择“下载并存储到本地系统”选项。 【设置图片链接】:如果你想使用文章内容页面中采集的图片作为这个文章的链接,那么你可以在这里设置。在本设置项中选择提取内容中的图片作为图片链接;如果不需要,可以选择不设置图片链接。

【附件】:这里有两个选项:“不要下载”和“下载并存储在本地系统”。除了展示的内容,部分文章还有附件供读者阅读。当采集器采集文章时,如果要删除附件采集,可以在此处选择“下载并存储在本地系统”。这时候下面会自动出现一个填充目标附件位置的标签条目,如图(2-15).然后填写可以用来定位附件的开始标记和结束标记在出现的两个字段中,点击。右边可以预览你想要的采集的附件信息,当采集器只需要采集文章的内容,而你不想要的时候图2-15【作者姓名获取方式】:当文章采集要在采集下方的文章内容中添加作者姓名时,您可以选择“不下载”。可以选择“指定作者姓名”,然后在下方【指定作者姓名为】右侧的输入框中填写要起草的作者姓名。当文章采集器想直接获取时原文章内容中的作者姓名,可以选择“采集 from the page”,下面会自动出现一个标签条目,填写目标作者的位置,如sho wn 在图 (2-16).图 2-16。然后在出现的两个条目中填写可用于定位作者位置的开始和结束标签。单击。右侧可以预览你想要的采集的作者信息。:【信息获取方式】:一般文章会标识其内容的来源。我们这里也特意添加了采集数据源功能,方便文章采集器获取源信息。

有时候采集people想在采集往下的文章内容中添加自己设置的数据源信息时,可以选择“指定源名称”,然后点击【指定数据源名称】 ] 下面为] 在右侧的输入框中填写要设置的数据源的信息。当文章采集想直接获取原创的文章内容数据源信息时,可以选择“采集source from the page”,会自动出现一个标签填写目标数据源的位置下面。项,如图(2-17)。然后在出现的两个字段中填写可以定位数据源位置的开始标记和结束标记。点击右侧预览文章数据采集的图2-17【获取摘要的方法】:一般文章会附带一些内容摘要,为文章提供内容摘要,这里我们也特意添加了采集摘要的功能。当文章当采集器想直接从文章内容开头截取一部分内容作为这个文章内容的摘要,选择从正文截取摘要,然后输入你想要的想在下方【获取正文】右侧的输入框中截取文章开头的内容中的字符数,有时候如果文章采集想直接获取原来的文章内容摘要信息,他们可以从页面中选择采集摘要,然后它会自动出现在下面的标签填写项为loca出现目标内容摘要,如图(2-18).图2-18 然后在出现的两个填写位置中填写可用于定位内容摘要位置的开始标签和结束标签。点击右侧可以预览你想要的信息采集文章内容摘要。

如果采集的文章中没有配置摘要,可以选择不采集。当所有必填的设置项都填好后,点击,本页填写的信息就设置成功了。以上四步都设置好后,一个完整的文章list内容页文章采集任务就设置好了。 RSS文章List采集Task Settings RSS 是站点与其他站点共享内容(也称为聚合内容)的一种简单方式,通常用于文章 和其他网站的顺序@。 RSS已成为目前最成功的XML应用,为信息的快速传播搭建了技术平台,让每个人都成为潜在的信息提供者。目前很多大型的网站都提供了RSS支持。基于这种情况,我们还专门开发了自动采集RSS文章功能。接下来,我们将详细介绍如何采集RSS文章。 RSS文章采集也与文章表页文章的采集相同。首先创建一个采集任务,通过(图2-3).现在)中的四个步骤分别介绍。 【第一步:基础】:本任务的基础设置页面和采集文章表页文章的设置页面为一页,如图(2-3).提供的设置大部分相同,唯一不同的是:在“采集List Type”项中选择RSS链接,在“采集List Address”中需要填写@的RSS格式的XML链接地址采集文章,例如新浪RSS频道文章中心下的文章要闻列表(HYPERLINK "/news/marquee/ddt.xml" /news/marquee/ddt.xml),功能和设置以及其他项目采集文章list 页面的选项相同。

这里不多介绍。 【步骤二:列表页面】:该页面的设置项主要包括内容去重的设置和填写RSS文章content页面的链接地址。内容页链接的设置是为下一步采集具体文章内容做准备,如图(2-19)。具体操作是在RSS文章中打开一个文章 @list page and put this 在这里的内容链接地址栏中填写文章content页面的地址,然后点击预览即可,这个设置的原因和文章content显示的原因是一样的普通文章列表的页面,使用相同的内容展示页面,这里需要注意的是此项必须填写。 图2-19【步骤3:内容页面】:该页面的设置功能是采集文章的列表页中的第三个步骤内容页设置的功能是一样的,如图(2-20)。具体操作也一样,就不介绍了图2-20【步骤4:附加】:该页面的样式如图(2-21) 图2-21 该页面设置的功能和操作方法同上) 采集文章 列表页面。通过以上步骤设置后,一个完整的RSS文章采集任务就完成了,接下来就可以采集RSS文章了。 2.1.3 修改任务 当信息采集器想修改已经创建的任务中的设置信息时,只需点击要更改的任务名称,在任务设置界面进行更改弹出。 2.1.4 删除任务时信息采集器 出于某种原因,采集一个文章在文章的列表中,要删除时可以选择采集任务删除,点击,采集任务将被删除。

2.1.5 启用和禁用任务 为了方便地启用和禁用采集任务,我们特地在任务列表的上半部分添加了这两个功能,如图(2-1).当采集管理者想要启用某些任务时,只需选择要启用的任务,然后点击,该任务被启用;当采集管理者想要停止一些已经启用的任务时, 2.1.6 设置计划 计划主要是为采集tasks 设置定时启动,此功能为采集器提供信息,智能采集方案方便采集器的维护,同时也提高了文章的时效性,具体操作点击弹出如图(2-22)界面,图2 -22,然后在弹出框中详细填写配置项,点击,采集plan添加成功。注意:配置项中的任务名称是指任务n 采集 任务的名称。此项必须正确填写,以确保任务执行正确。 2.1.7 设置模板 在2.1.1 部分,我们提到了设置模板的功能。下面我们来具体介绍一下。当文章管理员需要把某个采集设置为模板以备将来使用时,直接选择采集task,点击采集task右侧操作中的“设置为模板”记录。然后,这个采集task会作为模板保存到【Task Template】列中。 2.1.8 采集记录管理采集记录管理的功能配置在名称旁边每个采集任务方便信息采集器对采集记录被维护。

点击采集任务名称左侧的【查看记录】,进入采集记录管理页面,如图(2-23)。该页面共有三个设置,分别是:重置采集 @status,删除采集status,清除采集status。采集的文章的来源信息记录在下面的列表页,这个功能方便采集器查看采集信息下的文章的来源,每条记录都有一个链接,如图2-23 重置采集状态 每个采集任务执行后,所有采集记录都会列在这个页面上。当信息采集zhe发现采集down的一个文章的显示格式或内容不正确或不符合自己的需要时,需要更改任务设置,然后重新采集 @为这条文章,但必填 当没有被其他采集down的文章重新采集时,信息采集可以选择这条记录,点击,这条的采集标记记录将变为“不采集”。接下来采集器可以更改任务的设置,af ter更改,然后采集再次,现在你需要重新采集文章采集down,并将其保存到指定的文章组件如果采集人不想要不满意文章,可以删除文章source 列中原来的文章。删除采集记录,因为系统执行采集任务会记录在采集记录管理中。如果下次执行任务,如果采集记录管理中有采集记录,则跳过这条记录,而不是采集。所以如果@当采集器想要重新采集某条或部分文章记录,你必须在这里删除这些采集记录,然后执行任务,系统会重置文章这些记录采集又下来了。

具体操作是选中要删除的记录,点击,该记录就会被删除。清除采集记录 当采集器想在某个任务中重新采集文章时,则必须在该页面删除该任务中的所有记录。为了方便删除,我们提供了清除采集记录的功能。只要你点击这个页面,所有的记录都会被删除。 2.2 任务控制台 任务控制台主要提供采集任务的启停管理。其控制界面如图(2-24)。蓝色的任务工作区会显示采集任务进程的信息。所有要执行的任务必须在任务控制台中启动。需要说明的是这里是如果信息采集器已经创建了很多采集任务,但是你想指定任务什么时候执行,你必须在任务中把其他没有执行的任务的状态改为禁用状态设置,然后采集。如果要在采集的过程中停止采集,直接点击,采集Task就会被终止。图2-242.3 任务日志这里的功能主要是详细记录采集任务的操作,比如启动一个任务然后执行,这里会记录任务执行过程中发生的操作。如图(2-25):图2) -25 该功能用于采集任务有问题的时候查找和排查问题,当采集管理员不想在这里显示日志时,可以选择日志并单击它。如果管理员想要删除所有日志,点击,此时页面上的所有日志都会被清除。

另外,这里还配置了模糊查询功能。为了方便管理员查询记录。 2.4 任务模板 该模块主要存储2.1.7部分设置的任务模板,同时也记录了任务模板的相关信息,如模板名称、模板描述、采集地址。此外,其模块中还配置了模糊查询功能,方便管理员快速查找。如图(2-26):图2-26 如果管理员不需要某个模板,当您想删除它时,可以选择该模板并点击它。2.5 回收站删除任务信息记录在页面显示如下图,这里可以恢复删除的记录,只需要选中记录,点击按钮,如果确定要完全删除记录,点击记录下图中完全删除操作。 图2-273.HYPERLINK "7:8080/system/reptile/manager.jsp" \o "数据抓取管理" \t "right" 数据抓取管理3.功能说明@1 HYPERLINK "7:8080/system/reptile/manager.jsp" \o "数据采集管理" \t "right" 数据采集管理概述 根据用户的设置方法提取外部数据库中的数据信息并存储在本产品使用的数据库中,数据以文章的形式显示(即任意数据库表中的数据为以用户指定的方式捕获到本产品的文章表中)。

其特点:可以对任意数据库进行操作,可以联合抓取多张表的数据。操作简单,用户自定义任务和数据提取。您可以制定计划,定期、定量地从所需数据库中提取数据,并展示在本产品的前台网站文章页面上。 3.2 任务设置 图3-1 当您需要添加新的数据采集任务时,可以在弹出的页面中点击 添加采集任务。数据抓包的任务设置分为三步(基本信息设置、抓包信息设置、表属性映射设置),填写任务时必须一步一步填写。在每个步骤中,所有带有符号的项目都是必需的。 3.2.1 基本信息设置在第一步建立数据采集任务的基本信息页面。需要填写的项目如图(3-2)。图3-2【任务名称】:这个文章抓取任务的任务名称。当这个任务处于“启用”状态时, 执行抓取任务时,会执行此任务;当任务处于“禁用”状态时,执行抓取任务时会执行此任务。该任务不执行。 [目标列]:在这里你可以选择将捕获的文章放在该列文章源中。文章源列的选择基于用户的需求。选择单击时,将弹出用于选择页面组件的页面,如图所示图中(3-3)。在页面上选择需要的列文章source,然后点击。执行爬取任务后,抓取到的文章直接存储在指定列文章source中。图3-3【数据库连接池】:源数据库和新数据库都需要在系统管理下的数据库链接池中进行配置。

这里的数据库链接池要设置为数据源所在的连接池。 【每次最多抓取】:这里可以选择每次要抓取的文章的数量。 【发布状态】:这里有两个选项:“需要抓取后审核发布”和“抓取后立即发布”。当数据爬虫需要对抓取的文章进行审核,审核通过后可以发布,可以选择“抓取后需要审核后发布”。当数据爬虫审核抓获的文章When 未经审核发布。您可以选择“抓取后立即发布”。设置好需要的项目后,点击 ,进入第二步列表页面的设置。 3.2.2 抓包信息设置在抓包信息设置页面第二步显示(3-4)填一条sql查询语句。图3-4【任务名称】:这里显示的名字是第一步定义的任务名称。【抓取数据的条件设置】:数据爬虫可以根据自己的需要输入上图中的SQL语句,但必须保证SQL的正确性,否则点击Save After即会出现如图(3-5))的提示信息 图3-53.2.3 表属性映射设置在第三步表属性映射设置的设置页面如图图中(3-6) ,主要是数据抓取器设置了title字段、body字段、抓取文本格式、唯一标识字段、作者、数据源、摘要、关键词、Join时间。保存表属性映射设置,以便设置任务。

图3-63.2. 当数据采集器想要重新修改已经创建的任务中的设置信息时,只需点击要更改的任务记录后的任务设置即可。只需在界面中进行更改。 3.2 当数据抓取器由于某种原因不需要抓取文章 列表中的文章 时。如果你想删除它,你可以选择你要删除的抓取任务,点击它,这个抓取任务就被删除了。 3.2.6 开启任务和关闭任务 为了方便开启和关闭抓取任务的操作,我们特地在任务列表的上半部分增加了这两个功能,如图(3- 1).当数据采集管理器想要开启某些任务时,只需选择要开启的任务,然后点击,任务开启;当数据采集管理器想要停止一些已经开启的任务时,选择要禁用的任务,点击即可。3.2.7 设置计划 设置计划主要是为爬取任务的定时设置,该功能为数据爬虫提供智能爬取计划,方便数据抓取同时也提高了文章的时效性,具体操作是点击弹出界面如图3-7)。如图3-7,然后填写配置项在弹出框中点击,爬取计划添加成功3.2.8 Crawl 当数据爬虫想要管理已经创建的任务记录,只需点击任务记录后进入爬取记录管理界面如图(3-8).在此页面上,可以删除和清除记录。注意:这里删除的记录不会影响已经抓到文章source列的记录。

图3-83.3 任务控制台 任务控制台主要提供抓取任务的启动和停止管理。其控制界面如图(3-9)。所有任务要执行,必须在任务控制台中启动。这里需要注意的是,如果信息抓取器已经创建了很多抓取任务,但是想要要执行指定的任务,必须在任务设置中将其他没有执行的任务的状态改为禁用状态,然后进行爬取,如果在爬取过程中想停止爬取,直接点击,爬取任务图3-93.4 任务日志 这里的功能主要是详细记录抓包操作,比如启动一个任务然后执行,这里会记录执行过程中发生的操作如图(3-10):图3-10 这个函数的作用是的,当爬取任务出现问题的时候,方便我们查找问题和排查问题。当爬网管理器不希望在此处显示日志,您可以选择日志并单击它。如果管理员想要删除所有日志,点击所有日志,此时页面上的所有日志都会被清除。此外,这里还配置了模糊查询功能。方便管理人员查询记录。 3.5 回收站如下图 删除的任务信息记录显示在页面上,可以恢复删除的记录,只需选中该记录,点击按钮即可。如果您确定要完全删除一条记录,请点击下图完全删除该记录。 图3-11 查看全部

图2-9当所需的设置页面中如图(2)

首先,结束标签是:page。填写完毕后可以点击查看链接是否正常。如果不正常,请检查标签设置是否合适,网络是否畅通。图2-9 填写好需要的设置后,点击,列表页面的配置项就设置好了。内容页显示在第三步内容页设置页(2-10),主要是对采集器所需信息的方向如图2-10采集的文章内容,和这个方向是一样的 是在这个页面的源代码中通过特定的标记设置的,具体设置如下: 【标题提取方法】:这里有两个选项,自动提取和采集在页面上,选择“自动提取”时,系统将在文章的内容页面中自动删除文章标题采集。当您选择“从页面采集”时,文章标题你被采集锁定的会自动弹出,有两个填写框,分别是“Title Start Mark”和“Title End Mark”,如图(2-11).图2-11) Title Start Mark”和“Title End Mark”可以通过匹配来捕获 取文章的标题,一般用于标题开始标签和标题结束标签,填写后点击预览标记的标题e. 【文本提取方法】:这里也有两个选项,自动提取和从页面采集,当您选择“自动提取”时,系统会自动在文章内容中删除文章内容采集页。当您选择“来自页面的采集”时,您将被采集你锁定的文章内容。选择后会自动弹出两个填写框,分别是“Body Start Mark”和“Body End Mark”,如图(2-12).

图2-12“Body start tag”和“Body end tag”可以用来捕获文章的body。注意这里的标签必须能够唯一标识文章内容。填写完毕后,可以点击预览。 【采集text 格式】:这里有两个选项,分别是:纯文本和超文本。选择纯文本时,采集中的文章内容会以纯文本格式保存;选择超文本时,文章 Content来自采集将以超文本格式保存。 【过滤标签】:这里采集网页常用的标签。当采集不需要某个标签的效果时,可以在此处选择该标签,当采集时,会将选中的标签过滤掉。 【下一页内容】:这里有两个选项。当文章content页面没有下一页时,选择not采集分页,当文章content页面中有页面时,选择获取下一页或下一页的链接标签。这里的标签设置与板块列表页【列表下一页:】设置项“获取下一页”中标签的设置方法相同。如图(2-13)图2-13) 设置该页面的设置项后,点击,设置文章content的采集。附在第四步的附加设置页面,如图(2-14),主要是设置一些图片、附件以及一些用户想要采集在一些网页中的附加内容。这里的设置是可选的,如果用户有需要,可以设置,否则不需要设置,采用默认状态,接下来我们单独介绍页面上的设置项。

图2-14【任务名称】:显示这个采集任务的名称。 【发布状态】:这里有两个选项:“采集审核后发布”和“采集立即发布”。当信息采集需要对来自采集的文章进行审核,并且审核通过后才能发布(前提是网站中已经存在文章审核流),可以选择“采集需要审核后才能发布”,当信息采集器不需要审核文章采集并发布时,可以选择“采集后立即发布” 》。【内容内嵌图片】:一般情况下,网页上的文章内容都会嵌入一些图片来美化页面。文章采集器也希望采集system可以采集文章内容同时,内容中的图片也是采集下的,针对信息采集的需求,我们专门为此开发了这个功能,我们在这里为信息设置了两个选项采集器选择,当信息采集器考虑本地磁盘空间,不想把采集页面中的图片下载到本地,只想链接t图片、信息采集可以选择默认的“不要下载,链接到原地址(推荐)”选项。当信息采集器想将采集页面中的图片下载到本地时,使用方便,可以选择“下载并存储到本地系统”选项。 【设置图片链接】:如果你想使用文章内容页面中采集的图片作为这个文章的链接,那么你可以在这里设置。在本设置项中选择提取内容中的图片作为图片链接;如果不需要,可以选择不设置图片链接。

【附件】:这里有两个选项:“不要下载”和“下载并存储在本地系统”。除了展示的内容,部分文章还有附件供读者阅读。当采集器采集文章时,如果要删除附件采集,可以在此处选择“下载并存储在本地系统”。这时候下面会自动出现一个填充目标附件位置的标签条目,如图(2-15).然后填写可以用来定位附件的开始标记和结束标记在出现的两个字段中,点击。右边可以预览你想要的采集的附件信息,当采集器只需要采集文章的内容,而你不想要的时候图2-15【作者姓名获取方式】:当文章采集要在采集下方的文章内容中添加作者姓名时,您可以选择“不下载”。可以选择“指定作者姓名”,然后在下方【指定作者姓名为】右侧的输入框中填写要起草的作者姓名。当文章采集器想直接获取时原文章内容中的作者姓名,可以选择“采集 from the page”,下面会自动出现一个标签条目,填写目标作者的位置,如sho wn 在图 (2-16).图 2-16。然后在出现的两个条目中填写可用于定位作者位置的开始和结束标签。单击。右侧可以预览你想要的采集的作者信息。:【信息获取方式】:一般文章会标识其内容的来源。我们这里也特意添加了采集数据源功能,方便文章采集器获取源信息。

有时候采集people想在采集往下的文章内容中添加自己设置的数据源信息时,可以选择“指定源名称”,然后点击【指定数据源名称】 ] 下面为] 在右侧的输入框中填写要设置的数据源的信息。当文章采集想直接获取原创的文章内容数据源信息时,可以选择“采集source from the page”,会自动出现一个标签填写目标数据源的位置下面。项,如图(2-17)。然后在出现的两个字段中填写可以定位数据源位置的开始标记和结束标记。点击右侧预览文章数据采集的图2-17【获取摘要的方法】:一般文章会附带一些内容摘要,为文章提供内容摘要,这里我们也特意添加了采集摘要的功能。当文章当采集器想直接从文章内容开头截取一部分内容作为这个文章内容的摘要,选择从正文截取摘要,然后输入你想要的想在下方【获取正文】右侧的输入框中截取文章开头的内容中的字符数,有时候如果文章采集想直接获取原来的文章内容摘要信息,他们可以从页面中选择采集摘要,然后它会自动出现在下面的标签填写项为loca出现目标内容摘要,如图(2-18).图2-18 然后在出现的两个填写位置中填写可用于定位内容摘要位置的开始标签和结束标签。点击右侧可以预览你想要的信息采集文章内容摘要。

如果采集的文章中没有配置摘要,可以选择不采集。当所有必填的设置项都填好后,点击,本页填写的信息就设置成功了。以上四步都设置好后,一个完整的文章list内容页文章采集任务就设置好了。 RSS文章List采集Task Settings RSS 是站点与其他站点共享内容(也称为聚合内容)的一种简单方式,通常用于文章 和其他网站的顺序@。 RSS已成为目前最成功的XML应用,为信息的快速传播搭建了技术平台,让每个人都成为潜在的信息提供者。目前很多大型的网站都提供了RSS支持。基于这种情况,我们还专门开发了自动采集RSS文章功能。接下来,我们将详细介绍如何采集RSS文章。 RSS文章采集也与文章表页文章的采集相同。首先创建一个采集任务,通过(图2-3).现在)中的四个步骤分别介绍。 【第一步:基础】:本任务的基础设置页面和采集文章表页文章的设置页面为一页,如图(2-3).提供的设置大部分相同,唯一不同的是:在“采集List Type”项中选择RSS链接,在“采集List Address”中需要填写@的RSS格式的XML链接地址采集文章,例如新浪RSS频道文章中心下的文章要闻列表(HYPERLINK "/news/marquee/ddt.xml" /news/marquee/ddt.xml),功能和设置以及其他项目采集文章list 页面的选项相同。

这里不多介绍。 【步骤二:列表页面】:该页面的设置项主要包括内容去重的设置和填写RSS文章content页面的链接地址。内容页链接的设置是为下一步采集具体文章内容做准备,如图(2-19)。具体操作是在RSS文章中打开一个文章 @list page and put this 在这里的内容链接地址栏中填写文章content页面的地址,然后点击预览即可,这个设置的原因和文章content显示的原因是一样的普通文章列表的页面,使用相同的内容展示页面,这里需要注意的是此项必须填写。 图2-19【步骤3:内容页面】:该页面的设置功能是采集文章的列表页中的第三个步骤内容页设置的功能是一样的,如图(2-20)。具体操作也一样,就不介绍了图2-20【步骤4:附加】:该页面的样式如图(2-21) 图2-21 该页面设置的功能和操作方法同上) 采集文章 列表页面。通过以上步骤设置后,一个完整的RSS文章采集任务就完成了,接下来就可以采集RSS文章了。 2.1.3 修改任务 当信息采集器想修改已经创建的任务中的设置信息时,只需点击要更改的任务名称,在任务设置界面进行更改弹出。 2.1.4 删除任务时信息采集器 出于某种原因,采集一个文章在文章的列表中,要删除时可以选择采集任务删除,点击,采集任务将被删除。

2.1.5 启用和禁用任务 为了方便地启用和禁用采集任务,我们特地在任务列表的上半部分添加了这两个功能,如图(2-1).当采集管理者想要启用某些任务时,只需选择要启用的任务,然后点击,该任务被启用;当采集管理者想要停止一些已经启用的任务时, 2.1.6 设置计划 计划主要是为采集tasks 设置定时启动,此功能为采集器提供信息,智能采集方案方便采集器的维护,同时也提高了文章的时效性,具体操作点击弹出如图(2-22)界面,图2 -22,然后在弹出框中详细填写配置项,点击,采集plan添加成功。注意:配置项中的任务名称是指任务n 采集 任务的名称。此项必须正确填写,以确保任务执行正确。 2.1.7 设置模板 在2.1.1 部分,我们提到了设置模板的功能。下面我们来具体介绍一下。当文章管理员需要把某个采集设置为模板以备将来使用时,直接选择采集task,点击采集task右侧操作中的“设置为模板”记录。然后,这个采集task会作为模板保存到【Task Template】列中。 2.1.8 采集记录管理采集记录管理的功能配置在名称旁边每个采集任务方便信息采集器对采集记录被维护。

点击采集任务名称左侧的【查看记录】,进入采集记录管理页面,如图(2-23)。该页面共有三个设置,分别是:重置采集 @status,删除采集status,清除采集status。采集的文章的来源信息记录在下面的列表页,这个功能方便采集器查看采集信息下的文章的来源,每条记录都有一个链接,如图2-23 重置采集状态 每个采集任务执行后,所有采集记录都会列在这个页面上。当信息采集zhe发现采集down的一个文章的显示格式或内容不正确或不符合自己的需要时,需要更改任务设置,然后重新采集 @为这条文章,但必填 当没有被其他采集down的文章重新采集时,信息采集可以选择这条记录,点击,这条的采集标记记录将变为“不采集”。接下来采集器可以更改任务的设置,af ter更改,然后采集再次,现在你需要重新采集文章采集down,并将其保存到指定的文章组件如果采集人不想要不满意文章,可以删除文章source 列中原来的文章。删除采集记录,因为系统执行采集任务会记录在采集记录管理中。如果下次执行任务,如果采集记录管理中有采集记录,则跳过这条记录,而不是采集。所以如果@当采集器想要重新采集某条或部分文章记录,你必须在这里删除这些采集记录,然后执行任务,系统会重置文章这些记录采集又下来了。

具体操作是选中要删除的记录,点击,该记录就会被删除。清除采集记录 当采集器想在某个任务中重新采集文章时,则必须在该页面删除该任务中的所有记录。为了方便删除,我们提供了清除采集记录的功能。只要你点击这个页面,所有的记录都会被删除。 2.2 任务控制台 任务控制台主要提供采集任务的启停管理。其控制界面如图(2-24)。蓝色的任务工作区会显示采集任务进程的信息。所有要执行的任务必须在任务控制台中启动。需要说明的是这里是如果信息采集器已经创建了很多采集任务,但是你想指定任务什么时候执行,你必须在任务中把其他没有执行的任务的状态改为禁用状态设置,然后采集。如果要在采集的过程中停止采集,直接点击,采集Task就会被终止。图2-242.3 任务日志这里的功能主要是详细记录采集任务的操作,比如启动一个任务然后执行,这里会记录任务执行过程中发生的操作。如图(2-25):图2) -25 该功能用于采集任务有问题的时候查找和排查问题,当采集管理员不想在这里显示日志时,可以选择日志并单击它。如果管理员想要删除所有日志,点击,此时页面上的所有日志都会被清除。

另外,这里还配置了模糊查询功能。为了方便管理员查询记录。 2.4 任务模板 该模块主要存储2.1.7部分设置的任务模板,同时也记录了任务模板的相关信息,如模板名称、模板描述、采集地址。此外,其模块中还配置了模糊查询功能,方便管理员快速查找。如图(2-26):图2-26 如果管理员不需要某个模板,当您想删除它时,可以选择该模板并点击它。2.5 回收站删除任务信息记录在页面显示如下图,这里可以恢复删除的记录,只需要选中记录,点击按钮,如果确定要完全删除记录,点击记录下图中完全删除操作。 图2-273.HYPERLINK "7:8080/system/reptile/manager.jsp" \o "数据抓取管理" \t "right" 数据抓取管理3.功能说明@1 HYPERLINK "7:8080/system/reptile/manager.jsp" \o "数据采集管理" \t "right" 数据采集管理概述 根据用户的设置方法提取外部数据库中的数据信息并存储在本产品使用的数据库中,数据以文章的形式显示(即任意数据库表中的数据为以用户指定的方式捕获到本产品的文章表中)。

其特点:可以对任意数据库进行操作,可以联合抓取多张表的数据。操作简单,用户自定义任务和数据提取。您可以制定计划,定期、定量地从所需数据库中提取数据,并展示在本产品的前台网站文章页面上。 3.2 任务设置 图3-1 当您需要添加新的数据采集任务时,可以在弹出的页面中点击 添加采集任务。数据抓包的任务设置分为三步(基本信息设置、抓包信息设置、表属性映射设置),填写任务时必须一步一步填写。在每个步骤中,所有带有符号的项目都是必需的。 3.2.1 基本信息设置在第一步建立数据采集任务的基本信息页面。需要填写的项目如图(3-2)。图3-2【任务名称】:这个文章抓取任务的任务名称。当这个任务处于“启用”状态时, 执行抓取任务时,会执行此任务;当任务处于“禁用”状态时,执行抓取任务时会执行此任务。该任务不执行。 [目标列]:在这里你可以选择将捕获的文章放在该列文章源中。文章源列的选择基于用户的需求。选择单击时,将弹出用于选择页面组件的页面,如图所示图中(3-3)。在页面上选择需要的列文章source,然后点击。执行爬取任务后,抓取到的文章直接存储在指定列文章source中。图3-3【数据库连接池】:源数据库和新数据库都需要在系统管理下的数据库链接池中进行配置。

这里的数据库链接池要设置为数据源所在的连接池。 【每次最多抓取】:这里可以选择每次要抓取的文章的数量。 【发布状态】:这里有两个选项:“需要抓取后审核发布”和“抓取后立即发布”。当数据爬虫需要对抓取的文章进行审核,审核通过后可以发布,可以选择“抓取后需要审核后发布”。当数据爬虫审核抓获的文章When 未经审核发布。您可以选择“抓取后立即发布”。设置好需要的项目后,点击 ,进入第二步列表页面的设置。 3.2.2 抓包信息设置在抓包信息设置页面第二步显示(3-4)填一条sql查询语句。图3-4【任务名称】:这里显示的名字是第一步定义的任务名称。【抓取数据的条件设置】:数据爬虫可以根据自己的需要输入上图中的SQL语句,但必须保证SQL的正确性,否则点击Save After即会出现如图(3-5))的提示信息 图3-53.2.3 表属性映射设置在第三步表属性映射设置的设置页面如图图中(3-6) ,主要是数据抓取器设置了title字段、body字段、抓取文本格式、唯一标识字段、作者、数据源、摘要、关键词、Join时间。保存表属性映射设置,以便设置任务。