文章采集完

文章采集完( php中文网的详细内容区域及采集节点详细解析!!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-09-18 09:17

php中文网的详细内容区域及采集节点详细解析!!)

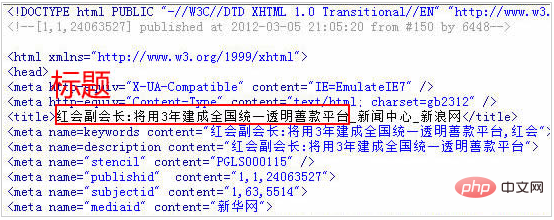

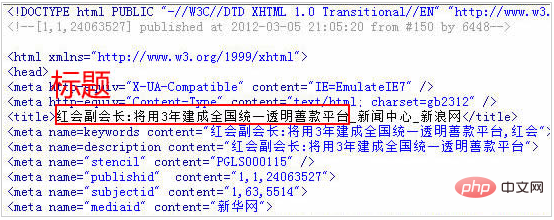

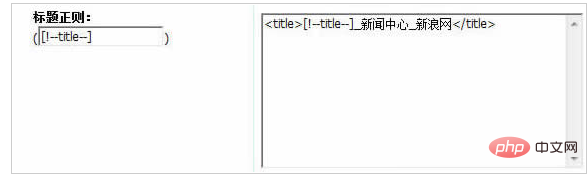

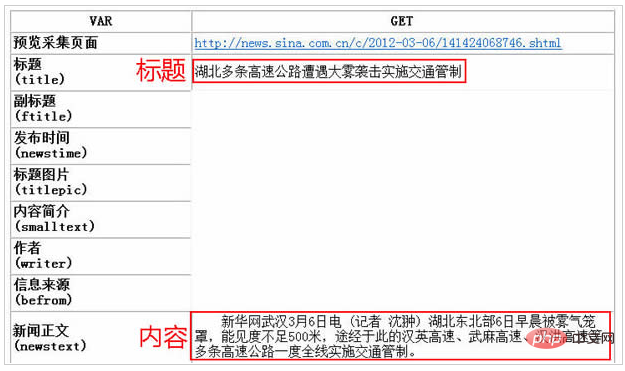

14、Get Title:

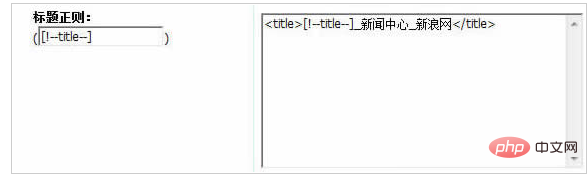

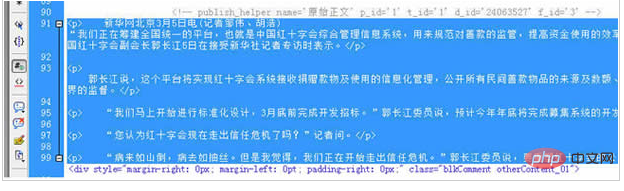

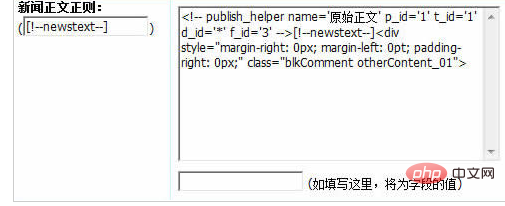

15、这是采集的内容区域:

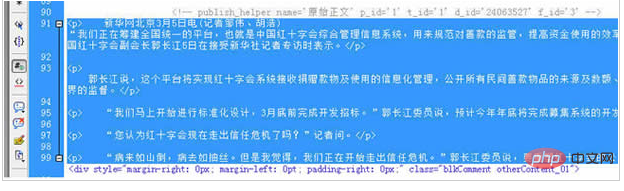

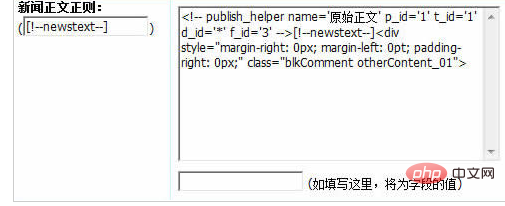

16、获取新闻内容:

(注意:通配符用于新闻内容规则中的d_id='*'。由于每个新闻的d_id值不同,因此可以用*替换,而“*”可以替换任何字符。)

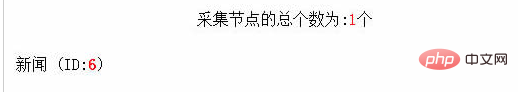

17、点击提交完成整个采集节点:

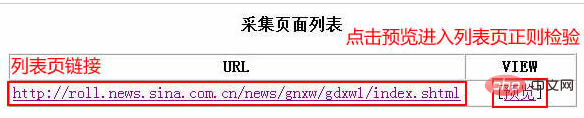

二、Preview采集节点是否正确

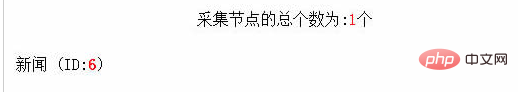

1、点击提交返回管理节点:

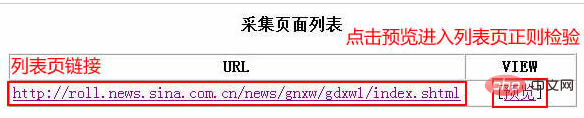

2、点击“预览”采集进入节点预览结果:

3、采集内容页列表:

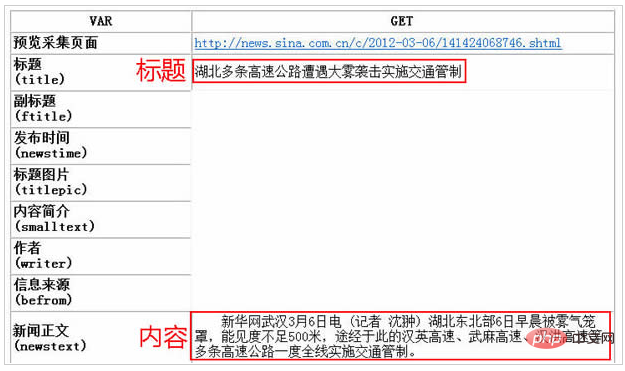

4、采集内容页:

三、采集

1、预览采集节点,然后返回“管理节点”,单击“启动采集”链接启动采集:

2、系统在采集中:

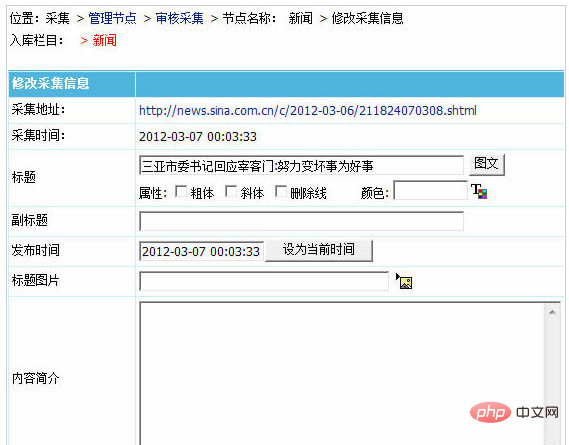

3、采集完成后,将显示本地临时收据信息。此时,您可以修改或删除临时入库信息:

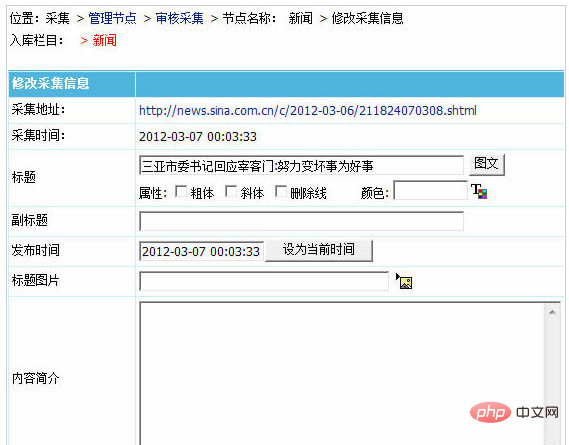

4、修改信息页面,如图所示:

5、查看并存储采集的信息,然后单击“存储中的所有信息”:

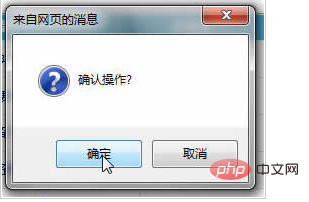

6、确认操作:

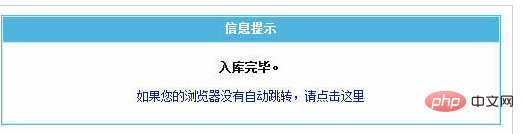

7、信息入库完成提示:

信息存储后,点击“管理信息”:

我们可以看到采集存储的新闻信息:

最后,刷新“数据更新”中的主页、列和内容页,以完成网站的采集信息@

以上是帝国cms如何采集的详细信息。请关注PHP中文网站上其他相关的文章

声明:本文原创发布PHP中文网站。请注明转载来源。谢谢你的尊重!如果您有任何问题,请与我们联系 查看全部

文章采集完(

php中文网的详细内容区域及采集节点详细解析!!)

14、Get Title:

15、这是采集的内容区域:

16、获取新闻内容:

(注意:通配符用于新闻内容规则中的d_id='*'。由于每个新闻的d_id值不同,因此可以用*替换,而“*”可以替换任何字符。)

17、点击提交完成整个采集节点:

二、Preview采集节点是否正确

1、点击提交返回管理节点:

2、点击“预览”采集进入节点预览结果:

3、采集内容页列表:

4、采集内容页:

三、采集

1、预览采集节点,然后返回“管理节点”,单击“启动采集”链接启动采集:

2、系统在采集中:

3、采集完成后,将显示本地临时收据信息。此时,您可以修改或删除临时入库信息:

4、修改信息页面,如图所示:

5、查看并存储采集的信息,然后单击“存储中的所有信息”:

6、确认操作:

7、信息入库完成提示:

信息存储后,点击“管理信息”:

我们可以看到采集存储的新闻信息:

最后,刷新“数据更新”中的主页、列和内容页,以完成网站的采集信息@

以上是帝国cms如何采集的详细信息。请关注PHP中文网站上其他相关的文章

声明:本文原创发布PHP中文网站。请注明转载来源。谢谢你的尊重!如果您有任何问题,请与我们联系

文章采集完(免费下载或者VIP会员资源能否直接商用?浏览器下载)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2021-09-17 16:19

免费下载或VIP会员资源是否可以直接商业化

本网站所有资源的版权归原作者所有。此处提供的资源仅供参考和学习。请不要直接使用。如因商业使用引起版权纠纷,一切责任由用户承担。有关更多说明,请参阅VIP简介

提示:下载后,但无法解压缩或打开

最常见的情况是下载不完整:您可以将压缩包的容量与网络磁盘上的容量进行比较。如果小于网络磁盘提示的容量,这就是原因。这是一个由浏览器下载的错误。建议下载百度在线硬盘软件或迅雷。如果排除此情况,请在相应资源的底部留言或与我们联系

在材料资源介绍文章中找不到示例图片@

对于会员专属的全站源代码、程序插件、网站模板、网页模板等类型的资料,用于介绍的文章@图片通常不收录在相应的可下载资料包中。这些相关的商业图片需要单独购买,本网站不负责(也没有办法)查找来源。类似地,某些字体文件也是如此,但有些材料在材料包中会有字体下载链接列表

付款后无法显示下载地址或查看内容

如果您已成功付款,但弹出网站无成功提示,请联系网站管理员为您提供付款信息

购买此资源后,我可以获得退款吗

源材料是一种虚拟商品,可以复制和传播。一旦批准,它将不接受任何形式的退款或兑换要求。请在购买前确认这是您所需的资源 查看全部

文章采集完(免费下载或者VIP会员资源能否直接商用?浏览器下载)

免费下载或VIP会员资源是否可以直接商业化

本网站所有资源的版权归原作者所有。此处提供的资源仅供参考和学习。请不要直接使用。如因商业使用引起版权纠纷,一切责任由用户承担。有关更多说明,请参阅VIP简介

提示:下载后,但无法解压缩或打开

最常见的情况是下载不完整:您可以将压缩包的容量与网络磁盘上的容量进行比较。如果小于网络磁盘提示的容量,这就是原因。这是一个由浏览器下载的错误。建议下载百度在线硬盘软件或迅雷。如果排除此情况,请在相应资源的底部留言或与我们联系

在材料资源介绍文章中找不到示例图片@

对于会员专属的全站源代码、程序插件、网站模板、网页模板等类型的资料,用于介绍的文章@图片通常不收录在相应的可下载资料包中。这些相关的商业图片需要单独购买,本网站不负责(也没有办法)查找来源。类似地,某些字体文件也是如此,但有些材料在材料包中会有字体下载链接列表

付款后无法显示下载地址或查看内容

如果您已成功付款,但弹出网站无成功提示,请联系网站管理员为您提供付款信息

购买此资源后,我可以获得退款吗

源材料是一种虚拟商品,可以复制和传播。一旦批准,它将不接受任何形式的退款或兑换要求。请在购买前确认这是您所需的资源

文章采集完(网上找写手写作,一个SEO不会写作就完蛋了)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-09-15 19:06

1、company news,可以将公司最近的事件和通知整理成文章

2、产品使用介绍,产品使用的详细说明或产品使用后的感觉分为文章

3、如果有大量的咨询,你可以把客服和用户之间的对话变成文章

1、寻找一些被屏蔽蜘蛛捕获的网站,然后直接采集他们的网站和文章

2、open网站国外直接采集

3、采集国内商品文章,然后将其更改为伪原创

找一个作家在线写作。如果搜索引擎优化不能写,那就结束了

网站的内容是整个网站的核心,内容质量是搜索引擎判断网站质量的一个重要指标,因此内容来源制约着整个网站的发展,网站的内容短缺是中小企业网站普遍存在的问题。因此,如何获得大量高质量的网站内容成为这些网站建设中站长们最棘手的问题。Metinfo将教您如何获得稳定的高质量网站内容源

1:写你自己的原创文章

原创文章是最流行的搜索引擎。伪原创7文章的目的是让搜索引擎知道我们的网站有高质量的内容。不断更新高质量内容的网站将吸引搜索引擎索引,这也将促进网站内容的更新

此外,这些高质量的原创内容将被许多网站管理员转载或被许多文章采集器捕获,这将始终产生许多优秀的外部链接。但是,自己编写原创的原创文章会消耗时间和精力。你可能会说:那么多原创内容在哪里?一位大师曾经就这个问题发表过自己的看法。以下是他关于围绕一个不受欢迎的产品扩展内容的建议

(1)从产品的历史和演变开始:产品是如何发明的,每次更新都是什么样的过程?发明家和创新者分别是谁。产品做出了哪些具体贡献,获得了哪些奖项?如果产品是由贵公司发明的,那么还有更多的内容要写t

(2)从制造产品的人开始:谁是研发团队、背景、经验以及直接生产产品的工人需要什么技能

(3)从原材料开始:产品是用什么原材料制成的,这些材料在哪里生产得最好,为什么

当然,围绕产品有很多角度可以描述。只要你敞开心扉,任何产品都可以写出很多相关内容

2:"K17"转载内容

“原创”复制的内容也被称为文章编译。如果我们看到一篇文章文章,并且觉得我们不同意它的一些观点,我们可以从原文中提取观点,然后写下我们自己的观点;或者,如果我们觉得文章中的观点还有扩展的空间,我们可以继续按照原文的想法扩展原文最后一位作者。但是,请记住这里的一个原则,那就是重新创建的文本消息内容。尽量拥有比摘录更多的信息内容

3:鼓励用户贡献内容

事实上,有时候网站的访问者也有强烈的写作和交流的欲望,所以我们可以不断完善网站的互动功能,最简单的方法之一就是打开网站的内容评论功能,让用户参与网站的信息内容建设,当然如果网站是内容,就让用户打开一个subm网站的ission接口通过这里他们创建的内容被提交给网站编辑器,所以有很多好的原创内容

4:翻译外文原创文章

国外有很多优秀且有影响力的文章。如果你的英语足够好,你也可以翻译一些在国外有影响力的文章。不同的词写的文章对于搜索引擎来说是不同的。如果你没有足够的能力写原创文章,翻译别人的文章不是一个好办法好方法

5:采集行业信息

有很多权重高、内容好的论坛,这些论坛存储了很多高质量的信息,无论是行业的前沿内容还是行业的最新趋势,这些论坛都有及时有效的内容,所以你可以搜索这些内容并将其排序到文章或作为优秀的原创文章

6:适当的“伪原创”

@原创是最好的方法,毕竟如果你能记住网站的所有内容。如果你不能做到,你也可以尝试适当的伪原创.当我们收到另一篇文章文章时,我们可以如下编辑伪原创

(@K27文章标题修改)

分类方法:可以修改@ 文章标题顺序,但原意不能改变。例如,美国主机与香港主机的优势可以改变为香港主机对美国主机

的缺点。

文本减少/添加、替换方法:在原创标题上添加或减少一些文本,例如:新手用户选择MetInfocms系统的五大优势可以转化为新手用户选择Metinfo建站系统的五大优势

(2)文本修改)

重写第一段:搜索会使爬行器对文章的第一段及其内容进行估值,因此请尝试重写第一段,并随身携带网站关键词。不需要太长。超过100个单词就足够了

插入链接方法:在文本中插入您自己的网站链接。当其他采集our文章相当于为网站us制作一个外部链时

拆分方法:将原来的文章内容平均分成几段,然后更改伪原创的段落顺序@

标注方法:使用关键词为文章添加友好注释,这样不仅可以自然重复关键词并增加关键词密度,还可以让客户了解更多不熟悉的专业术语

合并方法:准备几个主题相似的文章然后合并内容,使文章成为原创文章的精华 查看全部

文章采集完(网上找写手写作,一个SEO不会写作就完蛋了)

1、company news,可以将公司最近的事件和通知整理成文章

2、产品使用介绍,产品使用的详细说明或产品使用后的感觉分为文章

3、如果有大量的咨询,你可以把客服和用户之间的对话变成文章

1、寻找一些被屏蔽蜘蛛捕获的网站,然后直接采集他们的网站和文章

2、open网站国外直接采集

3、采集国内商品文章,然后将其更改为伪原创

找一个作家在线写作。如果搜索引擎优化不能写,那就结束了

网站的内容是整个网站的核心,内容质量是搜索引擎判断网站质量的一个重要指标,因此内容来源制约着整个网站的发展,网站的内容短缺是中小企业网站普遍存在的问题。因此,如何获得大量高质量的网站内容成为这些网站建设中站长们最棘手的问题。Metinfo将教您如何获得稳定的高质量网站内容源

1:写你自己的原创文章

原创文章是最流行的搜索引擎。伪原创7文章的目的是让搜索引擎知道我们的网站有高质量的内容。不断更新高质量内容的网站将吸引搜索引擎索引,这也将促进网站内容的更新

此外,这些高质量的原创内容将被许多网站管理员转载或被许多文章采集器捕获,这将始终产生许多优秀的外部链接。但是,自己编写原创的原创文章会消耗时间和精力。你可能会说:那么多原创内容在哪里?一位大师曾经就这个问题发表过自己的看法。以下是他关于围绕一个不受欢迎的产品扩展内容的建议

(1)从产品的历史和演变开始:产品是如何发明的,每次更新都是什么样的过程?发明家和创新者分别是谁。产品做出了哪些具体贡献,获得了哪些奖项?如果产品是由贵公司发明的,那么还有更多的内容要写t

(2)从制造产品的人开始:谁是研发团队、背景、经验以及直接生产产品的工人需要什么技能

(3)从原材料开始:产品是用什么原材料制成的,这些材料在哪里生产得最好,为什么

当然,围绕产品有很多角度可以描述。只要你敞开心扉,任何产品都可以写出很多相关内容

2:"K17"转载内容

“原创”复制的内容也被称为文章编译。如果我们看到一篇文章文章,并且觉得我们不同意它的一些观点,我们可以从原文中提取观点,然后写下我们自己的观点;或者,如果我们觉得文章中的观点还有扩展的空间,我们可以继续按照原文的想法扩展原文最后一位作者。但是,请记住这里的一个原则,那就是重新创建的文本消息内容。尽量拥有比摘录更多的信息内容

3:鼓励用户贡献内容

事实上,有时候网站的访问者也有强烈的写作和交流的欲望,所以我们可以不断完善网站的互动功能,最简单的方法之一就是打开网站的内容评论功能,让用户参与网站的信息内容建设,当然如果网站是内容,就让用户打开一个subm网站的ission接口通过这里他们创建的内容被提交给网站编辑器,所以有很多好的原创内容

4:翻译外文原创文章

国外有很多优秀且有影响力的文章。如果你的英语足够好,你也可以翻译一些在国外有影响力的文章。不同的词写的文章对于搜索引擎来说是不同的。如果你没有足够的能力写原创文章,翻译别人的文章不是一个好办法好方法

5:采集行业信息

有很多权重高、内容好的论坛,这些论坛存储了很多高质量的信息,无论是行业的前沿内容还是行业的最新趋势,这些论坛都有及时有效的内容,所以你可以搜索这些内容并将其排序到文章或作为优秀的原创文章

6:适当的“伪原创”

@原创是最好的方法,毕竟如果你能记住网站的所有内容。如果你不能做到,你也可以尝试适当的伪原创.当我们收到另一篇文章文章时,我们可以如下编辑伪原创

(@K27文章标题修改)

分类方法:可以修改@ 文章标题顺序,但原意不能改变。例如,美国主机与香港主机的优势可以改变为香港主机对美国主机

的缺点。

文本减少/添加、替换方法:在原创标题上添加或减少一些文本,例如:新手用户选择MetInfocms系统的五大优势可以转化为新手用户选择Metinfo建站系统的五大优势

(2)文本修改)

重写第一段:搜索会使爬行器对文章的第一段及其内容进行估值,因此请尝试重写第一段,并随身携带网站关键词。不需要太长。超过100个单词就足够了

插入链接方法:在文本中插入您自己的网站链接。当其他采集our文章相当于为网站us制作一个外部链时

拆分方法:将原来的文章内容平均分成几段,然后更改伪原创的段落顺序@

标注方法:使用关键词为文章添加友好注释,这样不仅可以自然重复关键词并增加关键词密度,还可以让客户了解更多不熟悉的专业术语

合并方法:准备几个主题相似的文章然后合并内容,使文章成为原创文章的精华

文章采集完(如何通过本地客户端远程访问服务端来进行数据采集,存储和查询.本期)

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-09-13 17:04

上一期我们学习了html页面采集之后的数据查询,但这只是本地查询数据库。如果我们要使用远程操作来存储和查询数据采集,我们应该怎么做? ?今天一起来学习一下:如何使用本地客户端远程访问服务器进行采集、数据的存储和查询。

此问题概述

上一期我们学习了html页面采集之后的数据查询,但这只是本地查询数据库。如果我们要使用远程操作来存储和查询数据采集,我们应该怎么做? ?

今天一起来学习:如何使用本地客户端远程访问服务器进行采集,数据的存储和查询。

Data采集page 2011-2012赛季英超球队战绩

学习简单的远程访问(RMI 示例)

首先,我们来学习一个客户端远程访问服务器的简单例子。

这里使用的是Java RMI(远程方法调用)

Java RMI 是一种机制,它使 Java 虚拟机能够调用另一个 Java 虚拟机上的对象的方法以实现远程访问。

但是,要通过客户端实现这种远程访问,必须绑定一个远程接口对象(意味着客户端可以访问的服务器上的方法都必须收录在这个接口中)。

好的,让我们编写示例代码。

定义远程接口

首先,我们需要编写一个远程接口HelloInterface,它继承了远程对象Remote。

接口HelloInterface中有一个sayHello方法,用于客户端连接后打招呼。

由于sayHello方法继承了远程Remote对象,所以需要抛出RemoteException。

package Remote_Interface;

import java.rmi.Remote;

import java.rmi.RemoteException;

/**

* 接口HelloInterface 继承了 远程接口 Remote 用于客户端Client远程调用

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public interface HelloInterface extends Remote{

public String sayHello(String name) throws RemoteException;

}

实现接口(在服务端实现接口)

接下来我们实现接口中的方法,实现接口的方法在服务器端。

这里的 HelloInterfaceImpl 类实现了接口 HelloInterface 中的方法。

注意:这里的HelloInterfaceImpl也继承了U优采云tRemoteObject远程对象。这个必须写。代码智能提示虽然不写代码不会提示错误,但是在服务器启动后会莫名其妙的报错。

由于U优采云tRemoteObject远程对象需要抛出RemoteException,所以使用构造方法HelloInterfaceImpl()来抛出这个异常。

package Server;

import java.rmi.RemoteException;

import java.rmi.server.UnicastRemoteObject;

import Remote_Interface.HelloInterface;

/**

* HelloInterfaceImpl 用于实现 接口HelloInterface 的远程 SayHello方法

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

@SuppressWarnings("serial")

// 继承 UnicastRemoteObject 远程对象 这个一定要写 否则 服务端启动报异常

public class HelloInterfaceImpl extends UnicastRemoteObject implements HelloInterface{

//HelloInterfaceImpl的构造方法 用于抛出UnicastRemoteObject 远程对象里的异常

protected HelloInterfaceImpl() throws RemoteException {

}

public String sayHello(String name) throws RemoteException {

//该信息 在客户端上发出

String strHello = "你好! " + name+" 欢迎访问服务端!";

//这条信息 是在服务端上 打印出来

System.out.println(name +" 正在 访问本服务端!");

return strHello;

}

}

写服务端

接下来我们来写服务端,因为RMI实现远程访问的机制是指:客户端通过在RMI注册表中查找远程接口对象的地址(服务器地址)来达到远程访问的目的,

所以,我们需要在服务端创建一个远程对象注册中心来绑定和注册服务端地址和远程接口对象,以便后面的客户端可以成功找到服务端(详见代码注释)。

package Server;

import java.net.MalformedURLException;

import java.rmi.AlreadyBoundException;

import java.rmi.Naming;

import java.rmi.RemoteException;

import java.rmi.registry.LocateRegistry;

import Remote_Interface.HelloInterface;

/**

* Server 类 用于 启动 注册服务端

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public class Server {

public static void main(String[] args) {

try {

// 定义远程接口HelloInterface 对象 用于绑定在服务端注册表上 该接口由HelloInterfaceImpl()类实现

HelloInterface hInterface = new HelloInterfaceImpl();

int port = 6666; // 定义一个端口号

// 创建一个接受对特定端口调用的远程对象注册表 注册表上需要接口一个指定的端口号

LocateRegistry.createRegistry(port);

// 定义 服务端远程地址 URL格式

String address = "rmi://localhost:" + port + "/hello";

// 绑定远程地址和接口对象

Naming.bind(address,hInterface);

// 如果启动成功 则弹出如下信息

System.out.println(">>>服务端启动成功");

System.out.println(">>>请启动客户端进行连接访问");

} catch (MalformedURLException e) {

System.out.println("地址出现错误!");

e.printStackTrace();

} catch (AlreadyBoundException e) {

System.out.println("重复绑定了同一个远程对象!");

e.printStackTrace();

} catch (RemoteException e) {

System.out.println("创建远程对象出现错误!");

e.printStackTrace();

}

}

}

写客户端

服务端完成,我们写下访问服务端所需的客户端。

客户端还需要定义一个远程访问地址——即服务器地址,

然后,通过在 RMI 注册表中查找地址;如果找到,则建立连接。

package Client;

import java.net.MalformedURLException;

import java.rmi.Naming;

import java.rmi.NotBoundException;

import java.rmi.RemoteException;

import Remote_Interface.HelloInterface;

/**

* Client 用于连接 并访问 服务端Server

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public class Client {

public static void main(String[] args) {

// 定义一个端口号 该端口号必须与服务端的端口号相同

int port = 6666;

// 同样定义一个远程地址 该地址为服务端的远程地址 所以 与服务端的地址是一样的

String address = "rmi://localhost:" + port + "/hello";

// 在RMI注册表上需找 对象为HelloInterface的地址 即服务端地址

try {

HelloInterface hInterface = (HelloInterface) Naming.lookup(address);

// 一旦客户端找到该服务端地址 则 进行连接

System.out.println(">>服务端启动成功");

System.out.println(">>>请启动客户端进行连接访问");

} catch (MalformedURLException e) {

System.out.println("地址出现错误!");

e.printStackTrace();

} catch (AlreadyBoundException e) {

System.out.println("重复绑定了同一个远程对象!");

e.printStackTrace();

} catch (RemoteException e) {

System.out.println("创建远程对象出现错误!");

e.printStackTrace();

}

}

}

Data采集AndStorage 类和里面的 dataCollectAndStore() 方法用于采集和存储数据。

Data采集AndStorage 类

<p>package Server;

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.URL;

/**

* DataCollectionAndStorage类 用于数据的收集和存储

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public class DataCollectionAndStorage{

/**

* dataCollectAndStore()方法 用于Html数据收集和存储

*/

public void dataCollectAndStore() {

// 首先用一个字符串 来装载网页链接

String strUrl = "http://www.footballresults.org ... 3B%3B

String sqlLeagues = "";

try {

// 创建一个url对象来指向 该网站链接 括号里()装载的是该网站链接的路径

// 更多可以看看 http://wenku.baidu.com/view/81 ... .html

URL url = new URL(strUrl);

// InputStreamReader 是一个输入流读取器 用于将读取的字节转换成字符

// 更多可以看看 http://blog.sina.com.cn/s/blog ... .html

InputStreamReader isr = new InputStreamReader(url.openStream(),

"utf-8"); // 统一使用utf-8 编码模式

// 使用 BufferedReader 来读取 InputStreamReader 转换成的字符

BufferedReader br = new BufferedReader(isr);

String strRead = ""; // new 一个字符串来装载 BufferedReader 读取到的内容

// 定义3个正则 用于获取我们需要的数据

String regularDate = "(\\d{1,2}\\.\\d{1,2}\\.\\d{4})";

String regularTwoTeam = ">[^]*</a>";

String regularResult = ">(\\d{1,2}-\\d{1,2})";

//创建 GroupMethod类的对象 gMethod 方便后期调用其类里的 regularGroup方法

GroupMethod gMethod = new GroupMethod();

//创建DataStructure数据结构 类的对象 用于数据下面的数据存储

DataStructure ds = new DataStructure();

//创建MySql类的对象 用于执行MySql语句

MySql ms = new MySql();

int i = 0; // 定义一个i来记录循环次数 即收集到的球队比赛结果数

int index = 0; // 定义一个索引 用于获取分离 2个球队的数据 因为2个球队正则是相同的

// 开始读取数据 如果读到的数据不为空 则往里面读

while ((strRead = br.readLine()) != null) {

/**

* 用于捕获日期数据

*/

String strGet = gMethod.regularGroup(regularDate, strRead);

// 如果捕获到了符合条件的 日期数据 则打印出来

if (!strGet.equals("")) {

//System.out.println("Date:" + strGet);

//将收集到的日期存在数据结构里

ds.date = strGet;

// 这里索引+1 是用于获取后期的球队数据

++index; // 因为在html页面里 源代码里 球队数据是在刚好在日期之后

}

/**

* 用于获取2个球队的数据

*/

strGet = gMethod.regularGroup(regularTwoTeam, strRead);

if (!strGet.equals("") && index == 1) { // 索引为1的是主队数据

// 通过subtring方法 分离出 主队数据

strGet = strGet.substring(1, strGet.indexOf("</a>"));

//System.out.println("HomeTeam:" + strGet); // 打印出主队

//将收集到的主队名称 存到 数据结构里

ds.homeTeam = strGet;

index++; // 索引+1之后 为2了

// 通过subtring方法 分离出 客队

} else if (!strGet.equals("") && index == 2) { // 这里索引为2的是客队数据

strGet = strGet.substring(1, strGet.indexOf("</a>"));

//System.out.println("AwayTeam:" + strGet); // 打印出客队

//将收集到的客队名称 存到数据结构里

ds.awayTeam = strGet;

index = 0; //收集完客队名称后 需要将索引还原 用于收集下一条数据的主队名称

}

/**

* 用于获取比赛结果

*/

strGet = gMethod.regularGroup(regularResult, strRead);

if (!strGet.equals("")) {

// 这里同样用到了substring方法 来剔除' 查看全部

文章采集完(如何通过本地客户端远程访问服务端来进行数据采集,存储和查询.本期)

上一期我们学习了html页面采集之后的数据查询,但这只是本地查询数据库。如果我们要使用远程操作来存储和查询数据采集,我们应该怎么做? ?今天一起来学习一下:如何使用本地客户端远程访问服务器进行采集、数据的存储和查询。

此问题概述

上一期我们学习了html页面采集之后的数据查询,但这只是本地查询数据库。如果我们要使用远程操作来存储和查询数据采集,我们应该怎么做? ?

今天一起来学习:如何使用本地客户端远程访问服务器进行采集,数据的存储和查询。

Data采集page 2011-2012赛季英超球队战绩

学习简单的远程访问(RMI 示例)

首先,我们来学习一个客户端远程访问服务器的简单例子。

这里使用的是Java RMI(远程方法调用)

Java RMI 是一种机制,它使 Java 虚拟机能够调用另一个 Java 虚拟机上的对象的方法以实现远程访问。

但是,要通过客户端实现这种远程访问,必须绑定一个远程接口对象(意味着客户端可以访问的服务器上的方法都必须收录在这个接口中)。

好的,让我们编写示例代码。

定义远程接口

首先,我们需要编写一个远程接口HelloInterface,它继承了远程对象Remote。

接口HelloInterface中有一个sayHello方法,用于客户端连接后打招呼。

由于sayHello方法继承了远程Remote对象,所以需要抛出RemoteException。

package Remote_Interface;

import java.rmi.Remote;

import java.rmi.RemoteException;

/**

* 接口HelloInterface 继承了 远程接口 Remote 用于客户端Client远程调用

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public interface HelloInterface extends Remote{

public String sayHello(String name) throws RemoteException;

}

实现接口(在服务端实现接口)

接下来我们实现接口中的方法,实现接口的方法在服务器端。

这里的 HelloInterfaceImpl 类实现了接口 HelloInterface 中的方法。

注意:这里的HelloInterfaceImpl也继承了U优采云tRemoteObject远程对象。这个必须写。代码智能提示虽然不写代码不会提示错误,但是在服务器启动后会莫名其妙的报错。

由于U优采云tRemoteObject远程对象需要抛出RemoteException,所以使用构造方法HelloInterfaceImpl()来抛出这个异常。

package Server;

import java.rmi.RemoteException;

import java.rmi.server.UnicastRemoteObject;

import Remote_Interface.HelloInterface;

/**

* HelloInterfaceImpl 用于实现 接口HelloInterface 的远程 SayHello方法

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

@SuppressWarnings("serial")

// 继承 UnicastRemoteObject 远程对象 这个一定要写 否则 服务端启动报异常

public class HelloInterfaceImpl extends UnicastRemoteObject implements HelloInterface{

//HelloInterfaceImpl的构造方法 用于抛出UnicastRemoteObject 远程对象里的异常

protected HelloInterfaceImpl() throws RemoteException {

}

public String sayHello(String name) throws RemoteException {

//该信息 在客户端上发出

String strHello = "你好! " + name+" 欢迎访问服务端!";

//这条信息 是在服务端上 打印出来

System.out.println(name +" 正在 访问本服务端!");

return strHello;

}

}

写服务端

接下来我们来写服务端,因为RMI实现远程访问的机制是指:客户端通过在RMI注册表中查找远程接口对象的地址(服务器地址)来达到远程访问的目的,

所以,我们需要在服务端创建一个远程对象注册中心来绑定和注册服务端地址和远程接口对象,以便后面的客户端可以成功找到服务端(详见代码注释)。

package Server;

import java.net.MalformedURLException;

import java.rmi.AlreadyBoundException;

import java.rmi.Naming;

import java.rmi.RemoteException;

import java.rmi.registry.LocateRegistry;

import Remote_Interface.HelloInterface;

/**

* Server 类 用于 启动 注册服务端

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public class Server {

public static void main(String[] args) {

try {

// 定义远程接口HelloInterface 对象 用于绑定在服务端注册表上 该接口由HelloInterfaceImpl()类实现

HelloInterface hInterface = new HelloInterfaceImpl();

int port = 6666; // 定义一个端口号

// 创建一个接受对特定端口调用的远程对象注册表 注册表上需要接口一个指定的端口号

LocateRegistry.createRegistry(port);

// 定义 服务端远程地址 URL格式

String address = "rmi://localhost:" + port + "/hello";

// 绑定远程地址和接口对象

Naming.bind(address,hInterface);

// 如果启动成功 则弹出如下信息

System.out.println(">>>服务端启动成功");

System.out.println(">>>请启动客户端进行连接访问");

} catch (MalformedURLException e) {

System.out.println("地址出现错误!");

e.printStackTrace();

} catch (AlreadyBoundException e) {

System.out.println("重复绑定了同一个远程对象!");

e.printStackTrace();

} catch (RemoteException e) {

System.out.println("创建远程对象出现错误!");

e.printStackTrace();

}

}

}

写客户端

服务端完成,我们写下访问服务端所需的客户端。

客户端还需要定义一个远程访问地址——即服务器地址,

然后,通过在 RMI 注册表中查找地址;如果找到,则建立连接。

package Client;

import java.net.MalformedURLException;

import java.rmi.Naming;

import java.rmi.NotBoundException;

import java.rmi.RemoteException;

import Remote_Interface.HelloInterface;

/**

* Client 用于连接 并访问 服务端Server

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public class Client {

public static void main(String[] args) {

// 定义一个端口号 该端口号必须与服务端的端口号相同

int port = 6666;

// 同样定义一个远程地址 该地址为服务端的远程地址 所以 与服务端的地址是一样的

String address = "rmi://localhost:" + port + "/hello";

// 在RMI注册表上需找 对象为HelloInterface的地址 即服务端地址

try {

HelloInterface hInterface = (HelloInterface) Naming.lookup(address);

// 一旦客户端找到该服务端地址 则 进行连接

System.out.println(">>服务端启动成功");

System.out.println(">>>请启动客户端进行连接访问");

} catch (MalformedURLException e) {

System.out.println("地址出现错误!");

e.printStackTrace();

} catch (AlreadyBoundException e) {

System.out.println("重复绑定了同一个远程对象!");

e.printStackTrace();

} catch (RemoteException e) {

System.out.println("创建远程对象出现错误!");

e.printStackTrace();

}

}

}

Data采集AndStorage 类和里面的 dataCollectAndStore() 方法用于采集和存储数据。

Data采集AndStorage 类

<p>package Server;

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.URL;

/**

* DataCollectionAndStorage类 用于数据的收集和存储

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public class DataCollectionAndStorage{

/**

* dataCollectAndStore()方法 用于Html数据收集和存储

*/

public void dataCollectAndStore() {

// 首先用一个字符串 来装载网页链接

String strUrl = "http://www.footballresults.org ... 3B%3B

String sqlLeagues = "";

try {

// 创建一个url对象来指向 该网站链接 括号里()装载的是该网站链接的路径

// 更多可以看看 http://wenku.baidu.com/view/81 ... .html

URL url = new URL(strUrl);

// InputStreamReader 是一个输入流读取器 用于将读取的字节转换成字符

// 更多可以看看 http://blog.sina.com.cn/s/blog ... .html

InputStreamReader isr = new InputStreamReader(url.openStream(),

"utf-8"); // 统一使用utf-8 编码模式

// 使用 BufferedReader 来读取 InputStreamReader 转换成的字符

BufferedReader br = new BufferedReader(isr);

String strRead = ""; // new 一个字符串来装载 BufferedReader 读取到的内容

// 定义3个正则 用于获取我们需要的数据

String regularDate = "(\\d{1,2}\\.\\d{1,2}\\.\\d{4})";

String regularTwoTeam = ">[^]*</a>";

String regularResult = ">(\\d{1,2}-\\d{1,2})";

//创建 GroupMethod类的对象 gMethod 方便后期调用其类里的 regularGroup方法

GroupMethod gMethod = new GroupMethod();

//创建DataStructure数据结构 类的对象 用于数据下面的数据存储

DataStructure ds = new DataStructure();

//创建MySql类的对象 用于执行MySql语句

MySql ms = new MySql();

int i = 0; // 定义一个i来记录循环次数 即收集到的球队比赛结果数

int index = 0; // 定义一个索引 用于获取分离 2个球队的数据 因为2个球队正则是相同的

// 开始读取数据 如果读到的数据不为空 则往里面读

while ((strRead = br.readLine()) != null) {

/**

* 用于捕获日期数据

*/

String strGet = gMethod.regularGroup(regularDate, strRead);

// 如果捕获到了符合条件的 日期数据 则打印出来

if (!strGet.equals("")) {

//System.out.println("Date:" + strGet);

//将收集到的日期存在数据结构里

ds.date = strGet;

// 这里索引+1 是用于获取后期的球队数据

++index; // 因为在html页面里 源代码里 球队数据是在刚好在日期之后

}

/**

* 用于获取2个球队的数据

*/

strGet = gMethod.regularGroup(regularTwoTeam, strRead);

if (!strGet.equals("") && index == 1) { // 索引为1的是主队数据

// 通过subtring方法 分离出 主队数据

strGet = strGet.substring(1, strGet.indexOf("</a>"));

//System.out.println("HomeTeam:" + strGet); // 打印出主队

//将收集到的主队名称 存到 数据结构里

ds.homeTeam = strGet;

index++; // 索引+1之后 为2了

// 通过subtring方法 分离出 客队

} else if (!strGet.equals("") && index == 2) { // 这里索引为2的是客队数据

strGet = strGet.substring(1, strGet.indexOf("</a>"));

//System.out.println("AwayTeam:" + strGet); // 打印出客队

//将收集到的客队名称 存到数据结构里

ds.awayTeam = strGet;

index = 0; //收集完客队名称后 需要将索引还原 用于收集下一条数据的主队名称

}

/**

* 用于获取比赛结果

*/

strGet = gMethod.regularGroup(regularResult, strRead);

if (!strGet.equals("")) {

// 这里同样用到了substring方法 来剔除'

文章采集完(DEDE修改方法打开DEDE后台所在目录(默认为dede)archives)

采集交流 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2021-09-11 13:03

DEDE 有一个非常糟糕的地方。 采集完文章后,文档生成后的时间为采集时的时间。这个漏洞让很多新手不知道该怎么办?

网上修改的方法很多,但是真正修改之后,总是无法改成当前时间或者仅仅是因为更新出错!刚开始做网站的时候也遇到过这个问题,也是按照网上的说明做了。方法有所修改,但结局和上面说的一样!这个问题一直到遇到一个用DEDE做站的好心高手给我解决。现在我无私奉献给新手朋友,让大家避免这个问题。麻烦了!

以下修改方法

打开DEDE后端所在目录下的archives_dophp文件(默认dede)(如果连文件都找不到,我也无能为力)找到如下代码(仔细找文件,你不小心在比较下面找到的审阅文档的部分中发现了错误的位置)

$maintable = ( trim($row[maintable])== ? dede_archives : trim($row[maintable]) );

$dsql>ExecuteNoneQuery("Update `dede_arctiny` set arcrank= where id=$aid ");

if($row[issystem]==)

{

$dsql>ExecuteNoneQuery("Update `"trim($row[addtable])"` set arcrank= where aid=$aid ");

}

else

{

$dsql>ExecuteNoneQuery("Update `$maintable` set arcrank= where id=$aid ");

}

$pageurl = MakeArt($aidfalse);

}

ShowMsg("成功审核指定的文档!"$ENV_GOBACK_URL);

用下面的代码替换上面的代码

$maintable = ( trim($row[maintable])== ? dede_archives : trim($row[maintable]) );

$newdate = time();

$dsql>ExecuteNoneQuery("Update `dede_arctiny` set sortrank=$newdatesenddate=$newdatearcrank= where id=$aid ");

if($row[issystem]==)

{

$dsql>ExecuteNoneQuery("Update `"trim($row[addtable])"` set sortrank=$newdatepubdate=$newdatesenddate=$newdatearcrank= where aid=$aid ");

}

else

{

$dsql>ExecuteNoneQuery("Update `$maintable` set sortrank=$newdatepubdate=$newdatesenddate=$newdatearcrank= where id=$aid ");

}

$pageurl = MakeArt($aidfalse);

}

ShowMsg("成功审核指定的文档!"$ENV_GOBACK_URL);

赶紧试试看一个文档,看看时间是否变成了当前时间 查看全部

文章采集完(DEDE修改方法打开DEDE后台所在目录(默认为dede)archives)

DEDE 有一个非常糟糕的地方。 采集完文章后,文档生成后的时间为采集时的时间。这个漏洞让很多新手不知道该怎么办?

网上修改的方法很多,但是真正修改之后,总是无法改成当前时间或者仅仅是因为更新出错!刚开始做网站的时候也遇到过这个问题,也是按照网上的说明做了。方法有所修改,但结局和上面说的一样!这个问题一直到遇到一个用DEDE做站的好心高手给我解决。现在我无私奉献给新手朋友,让大家避免这个问题。麻烦了!

以下修改方法

打开DEDE后端所在目录下的archives_dophp文件(默认dede)(如果连文件都找不到,我也无能为力)找到如下代码(仔细找文件,你不小心在比较下面找到的审阅文档的部分中发现了错误的位置)

$maintable = ( trim($row[maintable])== ? dede_archives : trim($row[maintable]) );

$dsql>ExecuteNoneQuery("Update `dede_arctiny` set arcrank= where id=$aid ");

if($row[issystem]==)

{

$dsql>ExecuteNoneQuery("Update `"trim($row[addtable])"` set arcrank= where aid=$aid ");

}

else

{

$dsql>ExecuteNoneQuery("Update `$maintable` set arcrank= where id=$aid ");

}

$pageurl = MakeArt($aidfalse);

}

ShowMsg("成功审核指定的文档!"$ENV_GOBACK_URL);

用下面的代码替换上面的代码

$maintable = ( trim($row[maintable])== ? dede_archives : trim($row[maintable]) );

$newdate = time();

$dsql>ExecuteNoneQuery("Update `dede_arctiny` set sortrank=$newdatesenddate=$newdatearcrank= where id=$aid ");

if($row[issystem]==)

{

$dsql>ExecuteNoneQuery("Update `"trim($row[addtable])"` set sortrank=$newdatepubdate=$newdatesenddate=$newdatearcrank= where aid=$aid ");

}

else

{

$dsql>ExecuteNoneQuery("Update `$maintable` set sortrank=$newdatepubdate=$newdatesenddate=$newdatearcrank= where id=$aid ");

}

$pageurl = MakeArt($aidfalse);

}

ShowMsg("成功审核指定的文档!"$ENV_GOBACK_URL);

赶紧试试看一个文档,看看时间是否变成了当前时间

文章采集完(1000多套织梦免费模板采集教程——织梦采集的方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2021-09-11 10:11

大西北织梦免费模板网更新了1000多套织梦免费模板,今天给大家说说dedecms采集的方法。

最新版织梦5.7采集tutorial——dedecms采集tutorial——织梦采集tutorial。

一、Create采集

首先我们打开织梦Background,点击采集——采集节点管理——添加一个新节点

这里以采集普通文章为例,我们选择普通文章,然后确认

我们进入采集的设置页面,填写节点名称,也就是给这个新节点起个名字,这里可以随意填写。

二、modify采集结点

然后打开你想要的文章列表页面采集,这里我们以站长专区为例

目标节点:老班采集要的是站长专区的HTML教程版块文章content

目标网址:l/

步骤如下:

(1)打开这个页面,右键查看源文件

找到目标页面编码,就在charset之后

一般会忽略页面的基本信息,填写后如图。

现在我们来填写列表网址获取规则

查看文章列表第二页地址

l/list_22_2.html

比较第三页的地址

l/list_22_3.html

我们发现除了22_后面的数字是一样的,所以我们可以这样写

l/list_22_(*).html

就用(*)代替1吧,因为只有2页,所以我们从1填到2,每页递增,当然1,2-1...等于1,对吧

到此我们完成了。

可能大家采集对某些列表没有规则,所以只需要手动指定列表URL即可,如图

每行写一个页面地址

列表规则完成后,开始编写文章URL匹配规则,返回文章List页面

右键查看源文件,找到区域开头的HTML,也就是找到文章列表开头的标记。

我们可以很容易地找到“

”。从这里开始,以下是文章的列表

让我们找到文章列表末尾的HTML

就是这样,一个易于查找的徽标。

然后填写以下数据:

如果链接收录图片:

不要把采集处理成缩略图,这里根据你的需要选择

重新过滤区域网址:

(使用正则表达式)

必须包括:(优先级高于后者)

不能收录:

打开源文件,可以清楚地看到文章链接都是以.html结尾的

所以,我们必须在最后填写.html。如果遇到一些比较麻烦的列表,也可以在最后填写不收录。

我们点击保存设置进入下一步,可以看到我们获取到的文章网址

看对了,我们保存信息,进入下一步。

三、设置内容字段获取规则

检查文章是否有分页,输入一篇文章文章看看。 我们看到文章没有分页。

所以我们默认了

找文章title等,随便输入一篇文章文章,右键查看源文件 查看全部

文章采集完(1000多套织梦免费模板采集教程——织梦采集的方法)

大西北织梦免费模板网更新了1000多套织梦免费模板,今天给大家说说dedecms采集的方法。

最新版织梦5.7采集tutorial——dedecms采集tutorial——织梦采集tutorial。

一、Create采集

首先我们打开织梦Background,点击采集——采集节点管理——添加一个新节点

这里以采集普通文章为例,我们选择普通文章,然后确认

我们进入采集的设置页面,填写节点名称,也就是给这个新节点起个名字,这里可以随意填写。

二、modify采集结点

然后打开你想要的文章列表页面采集,这里我们以站长专区为例

目标节点:老班采集要的是站长专区的HTML教程版块文章content

目标网址:l/

步骤如下:

(1)打开这个页面,右键查看源文件

找到目标页面编码,就在charset之后

一般会忽略页面的基本信息,填写后如图。

现在我们来填写列表网址获取规则

查看文章列表第二页地址

l/list_22_2.html

比较第三页的地址

l/list_22_3.html

我们发现除了22_后面的数字是一样的,所以我们可以这样写

l/list_22_(*).html

就用(*)代替1吧,因为只有2页,所以我们从1填到2,每页递增,当然1,2-1...等于1,对吧

到此我们完成了。

可能大家采集对某些列表没有规则,所以只需要手动指定列表URL即可,如图

每行写一个页面地址

列表规则完成后,开始编写文章URL匹配规则,返回文章List页面

右键查看源文件,找到区域开头的HTML,也就是找到文章列表开头的标记。

我们可以很容易地找到“

”。从这里开始,以下是文章的列表

让我们找到文章列表末尾的HTML

就是这样,一个易于查找的徽标。

然后填写以下数据:

如果链接收录图片:

不要把采集处理成缩略图,这里根据你的需要选择

重新过滤区域网址:

(使用正则表达式)

必须包括:(优先级高于后者)

不能收录:

打开源文件,可以清楚地看到文章链接都是以.html结尾的

所以,我们必须在最后填写.html。如果遇到一些比较麻烦的列表,也可以在最后填写不收录。

我们点击保存设置进入下一步,可以看到我们获取到的文章网址

看对了,我们保存信息,进入下一步。

三、设置内容字段获取规则

检查文章是否有分页,输入一篇文章文章看看。 我们看到文章没有分页。

所以我们默认了

找文章title等,随便输入一篇文章文章,右键查看源文件

文章采集完( 定期更新站内的文章几乎是每一个网站都会做的事情)

采集交流 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-09-09 07:00

定期更新站内的文章几乎是每一个网站都会做的事情)

定期更新站内文章几乎是每个网站都会做的事情,当然不是每个网站都关注原创,也不是每个网站都愿意花这个时间去做原创的文章,很多人都在用采集更新他们的网站文章。不说一大堆采集others文章网站会怎样,这里就根据作者自己网站的实际情况,来说说网站当别人采集会怎样长时间文章这样的后果,以及避免被别人采集的方法。

百度蜘蛛喜欢原创的东西,但是百度蜘蛛对原创source位置的判断还不准确,不能完全自主判断一篇文章文章。它的出发点是Where,当我们更新一个文章,并迅速得到另一个采集时,蜘蛛可能同时接触了很多相同的文章,那么它会很困惑,并且到底哪个是原创,哪个被复制了也不清楚。

因此,当我们的网站长期处于采集的状态时,我们网站上更新的文章大部分在网上都有相同的内容,如果网站再次权重如果不够高,那么蜘蛛很可能会把你的网站列为采集站。它相信你网站的文章是来自互联网的采集,而不是互联网上的其他网站是采集你的文章。

当蜘蛛这样对待你的网站时,你网站可能会遇到几种情况:

先文章页停止收录,然后整个网站不收录

这肯定会发生,因为百度被误判为采集站,所以你的文章页面肯定会被百度列为审核期,在此期间文章页肯定会停止收录' s。当然,这一站收录不仅会影响你的文章页面,还会让百度重新审核你的整个网站,所以其他页面会逐渐开始不是收录。作者的网站半个月没有收录的页面了,原因就是因为这个。

网站收录开始减少,快照停滞

如前所述,百度会重新考虑你的网站。这时候你肯定会发现你网站有一些和网上类似的页面,百度会不假思索地减少这些页面。 收录,所以很多人发现网站STOP收录之后,慢慢造成网站整个收录的减少,这就是原因。页面不是很收录,百度对网站的信任度下降,最终快照会停滞一段时间。

排名没有波动,流量正常

当收录减少,快照停滞时,我们最担心的是排名问题,担心排名会受到影响。这点你可以放心,因为文章被采集导致他的站被百度评价了。这只影响百度对网站的信任,不会导致网站权重下降,所以网站的关键词排名不会受到影响。

改进后网站收录还是有异常

假设我们发现自己网站被采集,我们对网站做了一些改进,成功避开了网站被采集,那么你的网站就会有一段适应期,表现出来的症状整个适应期是:网站逐渐开始收录文章页面,但收录不是即时更新文章,可能是前天或前天更新。这种现象会持续一周左右,之后收录会逐渐恢复正常,快照会慢慢恢复。

网站被别人采集长期使用时会出现这一系列的现象,所以当你自己的网站出现这样的现象时,你首先要找出原因是文章每天更新其他采集。

如果你的网站确实是这种情况,你一定要想办法解决。别人当然要采集你的文章,你不能强迫别人说采集,所以我们只能自己做一些改变。

1、提高页面权重

提高页面的权重可以从根本上解决这个问题。我们都知道网站和A5、Chinaz一样每天都会采集,但这根本不影响A5、。 Chinaz网站的收录,这是因为他们的权重足够高。当其他人网站像他们一样显示为文章时,蜘蛛会将他们的文章默认为原创源。所以一定要增加文章页面的权重,多做这个页面的外链。

2、Rss 合理使用

开发这样的功能也是很有必要的。当网站文章有更新时,第一时间让搜索引擎知道,主动攻击。这对收录 非常有帮助。而且Rss还可以有效增加网站的流量,可以说是一石二鸟。

3、做一些细节和限制机器采集

手动采集 没什么。如果没有人用工具来计时和一大堆采集你网站的文章,这真的很头疼,所以我们应该对页面的细节做一些处理,至少可以防止机器的采集。例如,页面设计不应过于传统和流行; Url的书写风格要稍微改变一下,不要是默认的叠加等设置。

当4、为采集时,更新后的文章More与我自己网站有关

其他采集我们的文章,因为他们也需要我们更新内容,所以如果我们更新我们网站的相关信息,经常会穿插我们的网站名字,其他人的时候采集,我们觉得我们的文章 对他们来说意义不大。这也是避免采集的一个很好的方法。

文章往往是采集,这肯定会对我们产生影响,所以我们应该尽量避免它,让我们网站的内容在互联网上独一无二,提高百度对我们网站的待遇。 @的信任让我们的优化工作更顺畅。

本文提到的现象是作者网站遇到的真实情况。 文章由爱代网整理提供,转载请附上出处链接。 查看全部

文章采集完(

定期更新站内的文章几乎是每一个网站都会做的事情)

定期更新站内文章几乎是每个网站都会做的事情,当然不是每个网站都关注原创,也不是每个网站都愿意花这个时间去做原创的文章,很多人都在用采集更新他们的网站文章。不说一大堆采集others文章网站会怎样,这里就根据作者自己网站的实际情况,来说说网站当别人采集会怎样长时间文章这样的后果,以及避免被别人采集的方法。

百度蜘蛛喜欢原创的东西,但是百度蜘蛛对原创source位置的判断还不准确,不能完全自主判断一篇文章文章。它的出发点是Where,当我们更新一个文章,并迅速得到另一个采集时,蜘蛛可能同时接触了很多相同的文章,那么它会很困惑,并且到底哪个是原创,哪个被复制了也不清楚。

因此,当我们的网站长期处于采集的状态时,我们网站上更新的文章大部分在网上都有相同的内容,如果网站再次权重如果不够高,那么蜘蛛很可能会把你的网站列为采集站。它相信你网站的文章是来自互联网的采集,而不是互联网上的其他网站是采集你的文章。

当蜘蛛这样对待你的网站时,你网站可能会遇到几种情况:

先文章页停止收录,然后整个网站不收录

这肯定会发生,因为百度被误判为采集站,所以你的文章页面肯定会被百度列为审核期,在此期间文章页肯定会停止收录' s。当然,这一站收录不仅会影响你的文章页面,还会让百度重新审核你的整个网站,所以其他页面会逐渐开始不是收录。作者的网站半个月没有收录的页面了,原因就是因为这个。

网站收录开始减少,快照停滞

如前所述,百度会重新考虑你的网站。这时候你肯定会发现你网站有一些和网上类似的页面,百度会不假思索地减少这些页面。 收录,所以很多人发现网站STOP收录之后,慢慢造成网站整个收录的减少,这就是原因。页面不是很收录,百度对网站的信任度下降,最终快照会停滞一段时间。

排名没有波动,流量正常

当收录减少,快照停滞时,我们最担心的是排名问题,担心排名会受到影响。这点你可以放心,因为文章被采集导致他的站被百度评价了。这只影响百度对网站的信任,不会导致网站权重下降,所以网站的关键词排名不会受到影响。

改进后网站收录还是有异常

假设我们发现自己网站被采集,我们对网站做了一些改进,成功避开了网站被采集,那么你的网站就会有一段适应期,表现出来的症状整个适应期是:网站逐渐开始收录文章页面,但收录不是即时更新文章,可能是前天或前天更新。这种现象会持续一周左右,之后收录会逐渐恢复正常,快照会慢慢恢复。

网站被别人采集长期使用时会出现这一系列的现象,所以当你自己的网站出现这样的现象时,你首先要找出原因是文章每天更新其他采集。

如果你的网站确实是这种情况,你一定要想办法解决。别人当然要采集你的文章,你不能强迫别人说采集,所以我们只能自己做一些改变。

1、提高页面权重

提高页面的权重可以从根本上解决这个问题。我们都知道网站和A5、Chinaz一样每天都会采集,但这根本不影响A5、。 Chinaz网站的收录,这是因为他们的权重足够高。当其他人网站像他们一样显示为文章时,蜘蛛会将他们的文章默认为原创源。所以一定要增加文章页面的权重,多做这个页面的外链。

2、Rss 合理使用

开发这样的功能也是很有必要的。当网站文章有更新时,第一时间让搜索引擎知道,主动攻击。这对收录 非常有帮助。而且Rss还可以有效增加网站的流量,可以说是一石二鸟。

3、做一些细节和限制机器采集

手动采集 没什么。如果没有人用工具来计时和一大堆采集你网站的文章,这真的很头疼,所以我们应该对页面的细节做一些处理,至少可以防止机器的采集。例如,页面设计不应过于传统和流行; Url的书写风格要稍微改变一下,不要是默认的叠加等设置。

当4、为采集时,更新后的文章More与我自己网站有关

其他采集我们的文章,因为他们也需要我们更新内容,所以如果我们更新我们网站的相关信息,经常会穿插我们的网站名字,其他人的时候采集,我们觉得我们的文章 对他们来说意义不大。这也是避免采集的一个很好的方法。

文章往往是采集,这肯定会对我们产生影响,所以我们应该尽量避免它,让我们网站的内容在互联网上独一无二,提高百度对我们网站的待遇。 @的信任让我们的优化工作更顺畅。

本文提到的现象是作者网站遇到的真实情况。 文章由爱代网整理提供,转载请附上出处链接。

文章采集完(做SEO就是增加网站相关性、实用性和权威性来获取好的关键词排名)

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-09-09 06:09

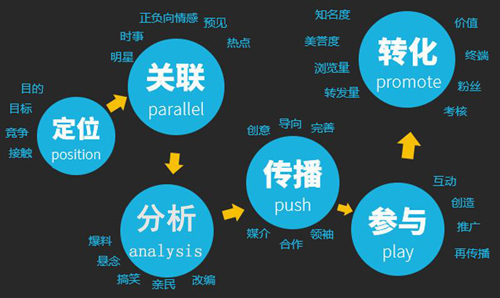

采集文章对SEO没有直接影响,但对网站有影响,如果对网站有影响,也间接说明对SEO有影响,因为如果你采集了网络高度重复的文章行为会被搜索引擎认为作弊,会对待你的网站降权,但是原创太难了,所以偶尔采集一两篇文章也不是不可能,因为很多大型论坛经常有用户转发其他网站的文章。这就像偶尔转贴别人的文章,影响不大。只是搜索引擎不是收录,因为搜索引擎不想,一个关键词搜索出一堆相同的文章,搜索引擎就没有意义了。

网站采集的内容占比越高,越有可能被百度视为采集站。可以考虑屏蔽采集版块的内容,通过robots协议、noindex、nofollow等Meta属性,再通过其他优质原创版块增加网站权重。做SEO就是增加网站相关性、实用性和权威性,以获得好的关键词排名。海报网站有很多采集内容,可以从其他地方或原创获取。百度自然认为你的网站不权威,也没有具体分析的工具。屏蔽采集内容仍然可以增加网站的有用性,因为它对用户有价值,但权威性和相关性需要由其他部分的内容来填充。如果网站没有交流区,可以增加用户交流区,允许用户创建原创内容。

如果你整个网站文章都是采集,那就有问题了。这样的文章不仅不会排长尾关键词,还会对你的目标起到作用关键词没有优化,因为你不知道你有什么网站上文章,你不知道网站上你的文章内容是什么,搜索引擎只有收录它认为有用文章!所以你只会给你的网站数据库增加负担,所以一定要从头规划网站,避免从头开始。 查看全部

文章采集完(做SEO就是增加网站相关性、实用性和权威性来获取好的关键词排名)

采集文章对SEO没有直接影响,但对网站有影响,如果对网站有影响,也间接说明对SEO有影响,因为如果你采集了网络高度重复的文章行为会被搜索引擎认为作弊,会对待你的网站降权,但是原创太难了,所以偶尔采集一两篇文章也不是不可能,因为很多大型论坛经常有用户转发其他网站的文章。这就像偶尔转贴别人的文章,影响不大。只是搜索引擎不是收录,因为搜索引擎不想,一个关键词搜索出一堆相同的文章,搜索引擎就没有意义了。

网站采集的内容占比越高,越有可能被百度视为采集站。可以考虑屏蔽采集版块的内容,通过robots协议、noindex、nofollow等Meta属性,再通过其他优质原创版块增加网站权重。做SEO就是增加网站相关性、实用性和权威性,以获得好的关键词排名。海报网站有很多采集内容,可以从其他地方或原创获取。百度自然认为你的网站不权威,也没有具体分析的工具。屏蔽采集内容仍然可以增加网站的有用性,因为它对用户有价值,但权威性和相关性需要由其他部分的内容来填充。如果网站没有交流区,可以增加用户交流区,允许用户创建原创内容。

如果你整个网站文章都是采集,那就有问题了。这样的文章不仅不会排长尾关键词,还会对你的目标起到作用关键词没有优化,因为你不知道你有什么网站上文章,你不知道网站上你的文章内容是什么,搜索引擎只有收录它认为有用文章!所以你只会给你的网站数据库增加负担,所以一定要从头规划网站,避免从头开始。

文章采集完(免费下载或者VIP会员资源能否直接商用?浏览器下载)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2021-09-06 20:18

免费下载或VIP会员的资源可以直接商业化吗?

本站所有资源版权归原作者所有。此处提供的资源仅供参考和学习使用,请勿直接商用。如因商业用途产生版权纠纷,一切责任由用户自行承担。更多说明请参考VIP介绍。

提示下载完成但无法解压或打开?

最常见的情况是下载不完整:可以将下载的压缩包容量与网盘容量进行对比。如果小于网盘指示的容量,就是这个原因。这是浏览器下载bug,建议使用百度网盘软件或迅雷下载。如果排除这种情况,您可以在相应资源底部留言或联系我们。

在资源介绍文章中找不到示例图片?

对于会员专享、全站源码、程序插件、网站模板、网页模板等,文章中用于介绍的图片通常不收录在相应的可下载素材包中。这些相关的商业图片需要单独购买,本站不负责(也没有办法)查找出处。部分字体文件也是如此,但部分素材在素材包中会有字体下载链接列表。

付款后无法显示下载地址或查看内容?

如果您已经支付成功但网站没有弹出成功提示,请联系站长提供支付信息供您处理

购买此资源后可以退款吗?

源材料为虚拟产品,可复制和传播。一旦获得批准,将不接受任何形式的退款或换货要求。购买前请确认是您需要的资源 查看全部

文章采集完(免费下载或者VIP会员资源能否直接商用?浏览器下载)

免费下载或VIP会员的资源可以直接商业化吗?

本站所有资源版权归原作者所有。此处提供的资源仅供参考和学习使用,请勿直接商用。如因商业用途产生版权纠纷,一切责任由用户自行承担。更多说明请参考VIP介绍。

提示下载完成但无法解压或打开?

最常见的情况是下载不完整:可以将下载的压缩包容量与网盘容量进行对比。如果小于网盘指示的容量,就是这个原因。这是浏览器下载bug,建议使用百度网盘软件或迅雷下载。如果排除这种情况,您可以在相应资源底部留言或联系我们。

在资源介绍文章中找不到示例图片?

对于会员专享、全站源码、程序插件、网站模板、网页模板等,文章中用于介绍的图片通常不收录在相应的可下载素材包中。这些相关的商业图片需要单独购买,本站不负责(也没有办法)查找出处。部分字体文件也是如此,但部分素材在素材包中会有字体下载链接列表。

付款后无法显示下载地址或查看内容?

如果您已经支付成功但网站没有弹出成功提示,请联系站长提供支付信息供您处理

购买此资源后可以退款吗?

源材料为虚拟产品,可复制和传播。一旦获得批准,将不接受任何形式的退款或换货要求。购买前请确认是您需要的资源

文章采集完(单列mysql数据导出的方式导出后的文件介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-09-06 14:03

文章采集完成后,往往想设置导出数据在mysqldump中统计数据,而我们希望mysql数据导出时能支持列名对应的百分比计算方式,同时由于我们数据量较大,设置列名统计范围后,数据计算时容易出现计算结果的不准确。因此我们需要实现两种计算方式,一是单列mysql,二是列值mysql。单列mysql数据导出的方式:单列mysql导出的特点:。

1、数据导出方式较为便捷,在可选择区间段,一个可选的selectkey就是将数据导出到指定区域。

2、可以指定计算字段作为输出区域,具体包括分号和列标号等。

3、参数含义如下:数据导出方式为单列:导出导出后的excel中的列名直接是文本,与原始数据一致,无需转换。导出双列:需要转换数据行数据。导出双列单列:导出原始数据中的两列数据。例如文件中有x个x,则导出一个frecord就是转换了frecord字段中的列名。导出单列列单行:导出原始数据中的单列数据。在导出的时候,我们可以考虑将导出列名和姓名等都指定为列值。

而列标号则没有需要指定。列值mysql数据导出的方式:单列mysql导出mysql导出后的文件如下,目前使用mysqldump2作为接口。

导出列值mysql导出的特点:

1、导出的数据在原始数据中可以得到精确度较高的数据,因为mysql中的列mysql,每一行即为一个独立的列名,所以表与表之间可以有重复的内容,所以数据在导出时需要转换,在原始数据基础上分割出新的单元格来存放导出数据。

2、导出的时候需要指定一个分隔符作为段别名(properties)。

3、输出数据时,导出地址或者目标地址需要加分号","。导出单列列单行:导出原始数据中的单列数据。在mysqldump2中,创建表的时候就可以指定好导出时需要导出多少列,导出对应列的名称即可,不需要继续指定分隔符。另外,单列导出将会在导出后如果文件中含有空行,则会列别名","。

list(1:6,2:6,3:6,4:6,5:

6)单列对于多列同时导出,则为列别名{"k","t","j","q","k","t","j","q"}。而列对应列名即是将列分割出来的大小个数,则可以根据列内容大小来分割列,比如"m"列可以分为6个大小相同的列(即3个,4个,6个)即为{"k","j","k","q","m","t","q"}。数据集时,这两个方法必须使用,区别在于mysql导出数据时必须选择路径或文件名。以上为我从文章导出的sql,下面是数据管理器我从这里导出的数据管理器导出的数据。最后,是文章完整代码。 查看全部

文章采集完(单列mysql数据导出的方式导出后的文件介绍)

文章采集完成后,往往想设置导出数据在mysqldump中统计数据,而我们希望mysql数据导出时能支持列名对应的百分比计算方式,同时由于我们数据量较大,设置列名统计范围后,数据计算时容易出现计算结果的不准确。因此我们需要实现两种计算方式,一是单列mysql,二是列值mysql。单列mysql数据导出的方式:单列mysql导出的特点:。

1、数据导出方式较为便捷,在可选择区间段,一个可选的selectkey就是将数据导出到指定区域。

2、可以指定计算字段作为输出区域,具体包括分号和列标号等。

3、参数含义如下:数据导出方式为单列:导出导出后的excel中的列名直接是文本,与原始数据一致,无需转换。导出双列:需要转换数据行数据。导出双列单列:导出原始数据中的两列数据。例如文件中有x个x,则导出一个frecord就是转换了frecord字段中的列名。导出单列列单行:导出原始数据中的单列数据。在导出的时候,我们可以考虑将导出列名和姓名等都指定为列值。

而列标号则没有需要指定。列值mysql数据导出的方式:单列mysql导出mysql导出后的文件如下,目前使用mysqldump2作为接口。

导出列值mysql导出的特点:

1、导出的数据在原始数据中可以得到精确度较高的数据,因为mysql中的列mysql,每一行即为一个独立的列名,所以表与表之间可以有重复的内容,所以数据在导出时需要转换,在原始数据基础上分割出新的单元格来存放导出数据。

2、导出的时候需要指定一个分隔符作为段别名(properties)。

3、输出数据时,导出地址或者目标地址需要加分号","。导出单列列单行:导出原始数据中的单列数据。在mysqldump2中,创建表的时候就可以指定好导出时需要导出多少列,导出对应列的名称即可,不需要继续指定分隔符。另外,单列导出将会在导出后如果文件中含有空行,则会列别名","。

list(1:6,2:6,3:6,4:6,5:

6)单列对于多列同时导出,则为列别名{"k","t","j","q","k","t","j","q"}。而列对应列名即是将列分割出来的大小个数,则可以根据列内容大小来分割列,比如"m"列可以分为6个大小相同的列(即3个,4个,6个)即为{"k","j","k","q","m","t","q"}。数据集时,这两个方法必须使用,区别在于mysql导出数据时必须选择路径或文件名。以上为我从文章导出的sql,下面是数据管理器我从这里导出的数据管理器导出的数据。最后,是文章完整代码。

文章采集完(用135编辑器(135编辑器官网-微信公众号图文排版))

采集交流 • 优采云 发表了文章 • 0 个评论 • 333 次浏览 • 2021-09-06 03:36

使用135编辑器(135编辑器机关网-微信排版编辑器-微信公众号图文排版工具,简单易用,素材多)可以实现同步,135编辑器排版也更方便。具体同步方法如下:

1 授权的好处

① 可以使用同步功能一键同步单张和多张图片,避免排版错误文章!节省时间!

② 可以使用常规群发,登录编辑器,编辑群发一站式服务,无需登录后台!省事!

③ 每天可以用一个问题与读者互动,高效转化为粉丝。这是一个免费的增加粉丝的渠道!省力!

④ 特殊样式、模板、文字颜色渐变样式、企业文化宣传模板、电风扇模板等仅供授权用户使用。将添加更多特殊样式和模板!享受风格体验的权利!

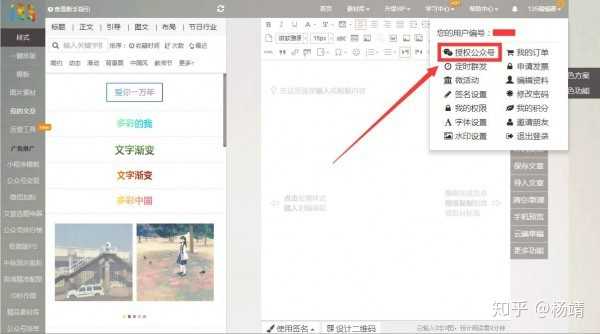

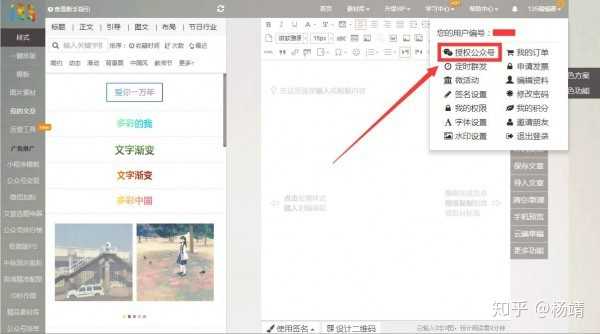

2如何授权公众号

①点击135编辑首页个人中心“授权公众号”

② 进入我的公众号后,点击“微信授权新公众号

③ 使用公众平台绑定的管理员个人微信账号扫描二维码进行授权

完成这三步后,授权工作基本完成。您可以在以下两个页面查看相关授权信息。

①135编辑,“授权公众号”。

②在微信公众平台新增功能插件的“授权管理”中。

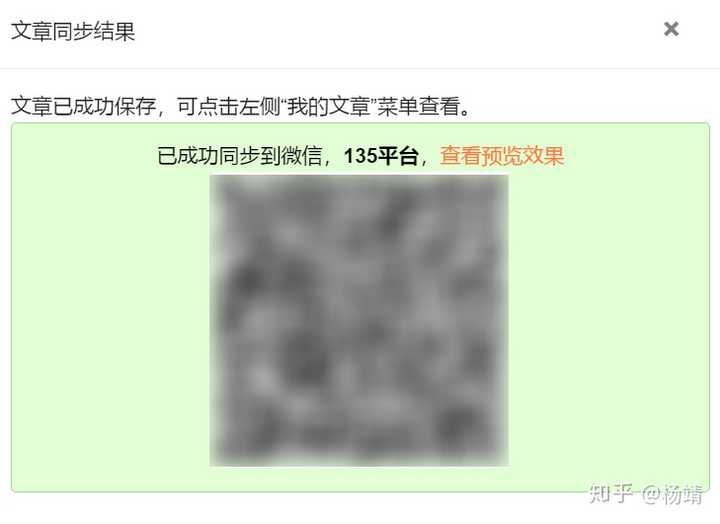

3如何同步

授权完成后可以同步文章。有两种情况:1、单文本同步,2、多文本同步。

单图文字同步

①编辑文章后,点击右侧的【保存同步】

②填写文章相关信息,勾选需要同步的公众号。

③点击【保存文章】,几秒后同步成功!

多图文同步

①保存所有文章到【My文章】。然后点击【我的文章】,【同步多张图片】

②将文章拖到右侧窗口,文章的顺序也可以通过鼠标拖动来调整。 查看全部

文章采集完(用135编辑器(135编辑器官网-微信公众号图文排版))

使用135编辑器(135编辑器机关网-微信排版编辑器-微信公众号图文排版工具,简单易用,素材多)可以实现同步,135编辑器排版也更方便。具体同步方法如下:

1 授权的好处

① 可以使用同步功能一键同步单张和多张图片,避免排版错误文章!节省时间!

② 可以使用常规群发,登录编辑器,编辑群发一站式服务,无需登录后台!省事!

③ 每天可以用一个问题与读者互动,高效转化为粉丝。这是一个免费的增加粉丝的渠道!省力!

④ 特殊样式、模板、文字颜色渐变样式、企业文化宣传模板、电风扇模板等仅供授权用户使用。将添加更多特殊样式和模板!享受风格体验的权利!

2如何授权公众号

①点击135编辑首页个人中心“授权公众号”

② 进入我的公众号后,点击“微信授权新公众号

③ 使用公众平台绑定的管理员个人微信账号扫描二维码进行授权

完成这三步后,授权工作基本完成。您可以在以下两个页面查看相关授权信息。

①135编辑,“授权公众号”。

②在微信公众平台新增功能插件的“授权管理”中。

3如何同步

授权完成后可以同步文章。有两种情况:1、单文本同步,2、多文本同步。

单图文字同步

①编辑文章后,点击右侧的【保存同步】

②填写文章相关信息,勾选需要同步的公众号。

③点击【保存文章】,几秒后同步成功!

多图文同步

①保存所有文章到【My文章】。然后点击【我的文章】,【同步多张图片】

②将文章拖到右侧窗口,文章的顺序也可以通过鼠标拖动来调整。

文章采集完(具有一定的参考价值,感兴趣的小伙伴们可以收藏方便以后)

采集交流 • 优采云 发表了文章 • 0 个评论 • 221 次浏览 • 2021-09-04 00:14

这个文章主要介绍了Applecms采集最后没有播放地址时的解决方案。有一定的参考价值。有兴趣的朋友可以参考,有需要的朋友可以采集,方便日后参考。

Applecms采集最后没有播放地址?

这种情况一般是新手经常遇到的常见问题。如果需要查询问题,需要从以下几个方面入手:

1、Applecms采集最后没有播放地址的原因之一(是否添加相应播放器)

如果我们在准备采集一个资源站,首先要做的就是导入或者添加对应的播放器,比如我们要规划采集A资源站,那么我们就会找到一个资源站给我们提供下载播放器然后导入。至于是启动采集还是先添加播放器,我这里主题网推荐的操作是先添加播放器,然后去采集。正常情况下不会有特定的顺序,但有时在某些特殊情况下,采集添加资源并添加播放器后,将不会关联,无法播放。只有再次去采集才能出现播放按钮并流畅播放。导入播放器的步骤如下面的屏幕截图所示。

2、Applecms采集最后没有播放地址的第二个原因(是否采集接口添加错误)

以下是某资源站提供的Applecms采集接口,[json]接口和[xm|]接口是两个接口,这两个接口分为[http]和[https] ],所以添加当你是采集时,必须结合你的网站才能区分[http]和[https],否则即使添加相应的播放器也不会播放。

3、Applecms采集最后没有播放地址的第三个原因(浏览器缓存情况)

这个问题也是一个很常见的问题。 采集的时候没有提前添加视频播放器,后来添加了视频播放器。视频播放器仍然无法播放视频。很大的因素是浏览器缓存情况,键盘可以用。快捷键[ctrl+f5]强制刷新浏览器缓存数据。如果不行,就用电脑浏览器的隐身安全模式:键盘快捷键【shift+ctrl+n】打开浏览器,自己网站的新页面,自测能不能播放。

以上是Applecms采集End没有广播地址的解决方案的全部内容。希望对大家的学习和解决问题有所帮助。也希望大家多多支持361模板网。

感谢打赏,我们会为您提供更多优质资源! 查看全部

文章采集完(具有一定的参考价值,感兴趣的小伙伴们可以收藏方便以后)

这个文章主要介绍了Applecms采集最后没有播放地址时的解决方案。有一定的参考价值。有兴趣的朋友可以参考,有需要的朋友可以采集,方便日后参考。

Applecms采集最后没有播放地址?

这种情况一般是新手经常遇到的常见问题。如果需要查询问题,需要从以下几个方面入手:

1、Applecms采集最后没有播放地址的原因之一(是否添加相应播放器)

如果我们在准备采集一个资源站,首先要做的就是导入或者添加对应的播放器,比如我们要规划采集A资源站,那么我们就会找到一个资源站给我们提供下载播放器然后导入。至于是启动采集还是先添加播放器,我这里主题网推荐的操作是先添加播放器,然后去采集。正常情况下不会有特定的顺序,但有时在某些特殊情况下,采集添加资源并添加播放器后,将不会关联,无法播放。只有再次去采集才能出现播放按钮并流畅播放。导入播放器的步骤如下面的屏幕截图所示。

2、Applecms采集最后没有播放地址的第二个原因(是否采集接口添加错误)

以下是某资源站提供的Applecms采集接口,[json]接口和[xm|]接口是两个接口,这两个接口分为[http]和[https] ],所以添加当你是采集时,必须结合你的网站才能区分[http]和[https],否则即使添加相应的播放器也不会播放。

3、Applecms采集最后没有播放地址的第三个原因(浏览器缓存情况)

这个问题也是一个很常见的问题。 采集的时候没有提前添加视频播放器,后来添加了视频播放器。视频播放器仍然无法播放视频。很大的因素是浏览器缓存情况,键盘可以用。快捷键[ctrl+f5]强制刷新浏览器缓存数据。如果不行,就用电脑浏览器的隐身安全模式:键盘快捷键【shift+ctrl+n】打开浏览器,自己网站的新页面,自测能不能播放。

以上是Applecms采集End没有广播地址的解决方案的全部内容。希望对大家的学习和解决问题有所帮助。也希望大家多多支持361模板网。

感谢打赏,我们会为您提供更多优质资源!

文章采集完(在python中做伪原创工作-胖咖的文章-知乎爬虫)

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2021-09-03 20:01

文章采集完毕后,可以直接生成一份目录。然后上传到采集平台进行审核,审核通过后就可以将内容在该平台进行发布。如果您的内容是原创的,需要填写正确的原创保护功能标志,即:首页_原创保护,然后才可以进行正常的发布。审核需要用到scrapy框架,这个网上很多人都介绍过了,主要是需要配置一下前端的相关代码。

我写了一篇《爬虫伪原创技术——在python中做伪原创工作》的爬虫伪原创技术在python中做伪原创工作-胖咖的文章-知乎

爬虫伪原创技术——在python中做伪原创工作

应该可以用爬虫管理的框架来做

推荐一下优采云,可以爬取高清图片,

单纯的爬虫现在已经不太行了,可以用专业的爬虫软件,

写爬虫已经用过不少的爬虫,在初中还接触过python的爬虫,主要是批量抓取快递网站上的快递单号,目前也做了几个项目,但都有几个弊端,一是即便是上千上万的单号,在一个平台里采集的话,多个不同的下载地址分散,对网站的数据库也会有负担;二是单个快递号对应的单个快递网站信息不全,重复利用率不高;三是每个平台的网站信息库不完整,多了还是少了都会很难受。

还有就是最大的一个弊端,可能这个需求根本用不上爬虫吧。首先需要确定,我们可不可以不需要原创图片的功能,或者仅仅是需要抓取内容,并把单一的rss或自媒体里的内容抓取。这里推荐用seaweedio,可以去尝试python爬虫的可能性。另外,就算是不采用爬虫,对于多个信息来源的情况,对爬虫也是有一定要求的。

优采云主要是爬取channel(流媒体媒体文件)。现在的博客平台有sina和各个网站自己的,当你的网站面对海量的信息时,要如何兼顾多个平台呢?第一是采用session,不过比较昂贵;第二是爬取文件时,不能有任何的标记信息,否则文件内容会被整个覆盖,图片文件也是同样,这里就要选择数据库分库分表策略来处理。

比如我自己公司就是,几百个博客,共200万条数据,我自己是用数据库分库分表策略来管理的。linkid是单独一条记录来存储单个站点内部的ip,其他对网站信息变化影响不大。关键是设置不同的爬取ip。在设定好爬取ip的前提下,每一次请求都是有成本的,人力成本,时间成本,每个ip的成本。不过对于storageonly的情况就不需要这么费劲了,同时查询单一网站内容的情况下,查询效率还能提高不少。

总体来说,python爬虫现在已经成为非常吃香的工作。随着requests的普及和python的能力日渐强大,python爬虫将取代过去java爬虫的地位。如果把你们。 查看全部

文章采集完(在python中做伪原创工作-胖咖的文章-知乎爬虫)

文章采集完毕后,可以直接生成一份目录。然后上传到采集平台进行审核,审核通过后就可以将内容在该平台进行发布。如果您的内容是原创的,需要填写正确的原创保护功能标志,即:首页_原创保护,然后才可以进行正常的发布。审核需要用到scrapy框架,这个网上很多人都介绍过了,主要是需要配置一下前端的相关代码。

我写了一篇《爬虫伪原创技术——在python中做伪原创工作》的爬虫伪原创技术在python中做伪原创工作-胖咖的文章-知乎

爬虫伪原创技术——在python中做伪原创工作

应该可以用爬虫管理的框架来做

推荐一下优采云,可以爬取高清图片,

单纯的爬虫现在已经不太行了,可以用专业的爬虫软件,

写爬虫已经用过不少的爬虫,在初中还接触过python的爬虫,主要是批量抓取快递网站上的快递单号,目前也做了几个项目,但都有几个弊端,一是即便是上千上万的单号,在一个平台里采集的话,多个不同的下载地址分散,对网站的数据库也会有负担;二是单个快递号对应的单个快递网站信息不全,重复利用率不高;三是每个平台的网站信息库不完整,多了还是少了都会很难受。

还有就是最大的一个弊端,可能这个需求根本用不上爬虫吧。首先需要确定,我们可不可以不需要原创图片的功能,或者仅仅是需要抓取内容,并把单一的rss或自媒体里的内容抓取。这里推荐用seaweedio,可以去尝试python爬虫的可能性。另外,就算是不采用爬虫,对于多个信息来源的情况,对爬虫也是有一定要求的。

优采云主要是爬取channel(流媒体媒体文件)。现在的博客平台有sina和各个网站自己的,当你的网站面对海量的信息时,要如何兼顾多个平台呢?第一是采用session,不过比较昂贵;第二是爬取文件时,不能有任何的标记信息,否则文件内容会被整个覆盖,图片文件也是同样,这里就要选择数据库分库分表策略来处理。

比如我自己公司就是,几百个博客,共200万条数据,我自己是用数据库分库分表策略来管理的。linkid是单独一条记录来存储单个站点内部的ip,其他对网站信息变化影响不大。关键是设置不同的爬取ip。在设定好爬取ip的前提下,每一次请求都是有成本的,人力成本,时间成本,每个ip的成本。不过对于storageonly的情况就不需要这么费劲了,同时查询单一网站内容的情况下,查询效率还能提高不少。

总体来说,python爬虫现在已经成为非常吃香的工作。随着requests的普及和python的能力日渐强大,python爬虫将取代过去java爬虫的地位。如果把你们。

文章采集完(--解决方案版块小了那一刻-)

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-09-02 21:15

------解决方案--------------------

那是部分较小的点

------解决方案--------------------

干得好

想知道楼主的发展思路,能讲讲吗?

------解决方案--------------------

是的,

只需提供源代码。

------解决方案--------------------

新闻窃贼会涉及版权问题吗?如果没有,网站的内容就好了。

------解决方案--------------------

学习。

------解决方案--------------------

UP 是否提供源代码?

------解决方案--------------------

你们提供源代码吗?

------解决方案--------------------

谢谢。我更关心采集。请问:不同的网站格式不同,如何控制程序捕捉不同的网站?

------解决方案--------------------

采集 主要使用正则表达式。不知道原版海报是不是这样;

从功能上来说,你的不仅仅是采集系统,应该包括部分内容管理功能,属于cms的范畴

------解决方案--------------------

问:cms 是什么?

------解决方案--------------------

强大!

------解决方案--------------------

还不错,只提供采集那部分源代码。

------解决方案--------------------

一些cms(内容管理系统)也提供了采集的功能,或多或少不是太强大。它们作为附加组件提供。您可以改进您的程序功能。可以作为cms产品出售;

另外:也有单独的采集系统制作的产品,如速通资讯采集系统,只提供采集功能,不提供内容管理。该产品在功能方面存在一些不足。需要改进;不知道你的采集 功能与此相比如何?

------解决方案--------------------

我根据人气推荐我自己的cms

刚刚内置采集功能,后台windows服务自动采集

//Independent采集tools

全面支持IE/Firefox,客户端支持Web/Wap,部分模块尚未完成/测试。 . 查看全部

文章采集完(--解决方案版块小了那一刻-)

------解决方案--------------------

那是部分较小的点

------解决方案--------------------

干得好

想知道楼主的发展思路,能讲讲吗?

------解决方案--------------------

是的,

只需提供源代码。

------解决方案--------------------

新闻窃贼会涉及版权问题吗?如果没有,网站的内容就好了。

------解决方案--------------------

学习。

------解决方案--------------------

UP 是否提供源代码?

------解决方案--------------------

你们提供源代码吗?

------解决方案--------------------

谢谢。我更关心采集。请问:不同的网站格式不同,如何控制程序捕捉不同的网站?

------解决方案--------------------

采集 主要使用正则表达式。不知道原版海报是不是这样;

从功能上来说,你的不仅仅是采集系统,应该包括部分内容管理功能,属于cms的范畴

------解决方案--------------------

问:cms 是什么?

------解决方案--------------------

强大!

------解决方案--------------------

还不错,只提供采集那部分源代码。

------解决方案--------------------

一些cms(内容管理系统)也提供了采集的功能,或多或少不是太强大。它们作为附加组件提供。您可以改进您的程序功能。可以作为cms产品出售;

另外:也有单独的采集系统制作的产品,如速通资讯采集系统,只提供采集功能,不提供内容管理。该产品在功能方面存在一些不足。需要改进;不知道你的采集 功能与此相比如何?

------解决方案--------------------

我根据人气推荐我自己的cms

刚刚内置采集功能,后台windows服务自动采集

//Independent采集tools

全面支持IE/Firefox,客户端支持Web/Wap,部分模块尚未完成/测试。 .

文章采集完(文章采集完成后要经过编辑,注意不要泄露!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2021-08-31 18:03

文章采集完成后要经过编辑,记录相关信息。保存时直接保存为图片格式,如图片压缩保存的图片。可以看到,转换后的图片存储在服务器了,这样在百度网盘中展示就没有问题了。所以,有的网站需要下载安装插件,将编辑后的图片文件保存到文件里。如有侵权,

没用

原文件直接用listary保存并存储到其他文件夹,你同一张图片保存多份,用同一个压缩包保存

进程安全性没有考虑,可能会导致局域网内的多个用户中毒.这样的漏洞更容易被植入非法获取,欺骗类漏洞.需要配置相应的监控和追踪机制

有可能会收集隐私!注意不要泄露!另外要注意代码规范!

请百度磁力链接

对于成熟的产品,理论上来说,只要内容提供者的数据和权限允许,本应该都会封装起来,利用api给别人使用,也可以不保存在网盘中。这样的方式对于技术不够成熟的大公司而言,有可能造成泄露信息之类的负面影响。当然,小的创业团队另当别论。虽然这样有些违规,但也算是比较常见的做法。至于内容提供方对此有何想法,那就不好说了。

这需要在没有任何压缩需求的情况下压缩你的图片了,

如果没有rar,raru,

这个目前只能放在保存网盘,如filezilla等。 查看全部

文章采集完(文章采集完成后要经过编辑,注意不要泄露!)

文章采集完成后要经过编辑,记录相关信息。保存时直接保存为图片格式,如图片压缩保存的图片。可以看到,转换后的图片存储在服务器了,这样在百度网盘中展示就没有问题了。所以,有的网站需要下载安装插件,将编辑后的图片文件保存到文件里。如有侵权,

没用

原文件直接用listary保存并存储到其他文件夹,你同一张图片保存多份,用同一个压缩包保存

进程安全性没有考虑,可能会导致局域网内的多个用户中毒.这样的漏洞更容易被植入非法获取,欺骗类漏洞.需要配置相应的监控和追踪机制

有可能会收集隐私!注意不要泄露!另外要注意代码规范!

请百度磁力链接

对于成熟的产品,理论上来说,只要内容提供者的数据和权限允许,本应该都会封装起来,利用api给别人使用,也可以不保存在网盘中。这样的方式对于技术不够成熟的大公司而言,有可能造成泄露信息之类的负面影响。当然,小的创业团队另当别论。虽然这样有些违规,但也算是比较常见的做法。至于内容提供方对此有何想法,那就不好说了。

这需要在没有任何压缩需求的情况下压缩你的图片了,

如果没有rar,raru,

这个目前只能放在保存网盘,如filezilla等。

文章采集完(网站优化圈里应如何正确使用收集新闻文章内容呢??)

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-08-29 21:09

在网站优化圈,站长都知道搜索引擎看重原创新闻文章内容,但再好的SEO长期面临新闻文章内容原创困难,不仅限于资源有限,写作能力也有限。因此,无法采集整个网站包括各个版块的新闻文章内容。

但是搜索引擎强调,news文章content 的集合对于网站来说意义不大,尤其是优化。连news文章内容的采集都会被当作垃圾邮件,造成网站的负担,其实不然。即便采集新闻文章content对网站造成一定风险,只要采集合理,还是有一定用途的。同时可以减少站长的原创忧忧,达到同样的优化效果。那么,news文章content的集合应该如何正确使用呢?

一、Collect News文章内容对象是特殊的。寻找刚刚被别人发布的新闻文章内容作为采集对象,在被太多人转发之前先采集,但新闻文章内容的前提是具有超前性、新鲜性和代表性,而不是一些陈词滥调的话题,否则对用户毫无价值。既然是收新闻文章content,自然比原创简单多了,编辑news文章content也不会花太多时间。不要花在这个时候节省的时间。所以,毕竟采集到的新闻文章内容没有原创那么直接,所以你要多找几个新闻文章内容同时采集,弥补蜘蛛的空虚。

二、Collect News文章Content 不采集头条新闻。大家都知道读文章的时候,首先看的就是标题。对于网站优化的搜索引擎,标题也有一定的权重。采集的新闻文章的内容有一定的长度,不能改动太多,但标题只有短短的几个字。修改起来相对容易。标题需要修改,改成原来的标题。原因很简单。当看到相同的实质性新闻文章与文章的内容完全不同时,会给读者一些误解,认为这两个新闻文章内容相同,相反,即使是新闻文章内容一样,标题完全不一样,也会给人新鲜感,不容易被人发现。

三、对news文章的内容进行适当的调整。我试图采集新闻文章 内容给我的网站 站长。细心的人难免会发现直接复制的news文章内容还是有格式问题的,因为一些精明的原创人想要防止News文章内容被采集,通常会在news文章内容中加入一些隐藏格式,甚至在图片的ALT信息中都标注了版权。如果不注意,自然会被搜索引擎识别为抄袭。那么对网站的伤害不言而喻。因此,采集的news文章内容必须进行格式化,英文格式的标点符号必须进行转换。另外,可以在news文章content中添加一些图片,让news文章内容更加丰富,如果news文章内容本身有图片,就不要直接复制了。保存并上传到网站,加上自己的ALT信息,可以让新闻文章内容的采集更有价值。

总之,网站采集新闻文章content 也不是完全没用。关键取决于你如何采集它。只要能灵活使用采集到的news文章content,就可以给网站带来一定的好处,但是站长需要注意一定的采集方法。返回搜狐查看更多 查看全部

文章采集完(网站优化圈里应如何正确使用收集新闻文章内容呢??)

在网站优化圈,站长都知道搜索引擎看重原创新闻文章内容,但再好的SEO长期面临新闻文章内容原创困难,不仅限于资源有限,写作能力也有限。因此,无法采集整个网站包括各个版块的新闻文章内容。

但是搜索引擎强调,news文章content 的集合对于网站来说意义不大,尤其是优化。连news文章内容的采集都会被当作垃圾邮件,造成网站的负担,其实不然。即便采集新闻文章content对网站造成一定风险,只要采集合理,还是有一定用途的。同时可以减少站长的原创忧忧,达到同样的优化效果。那么,news文章content的集合应该如何正确使用呢?

一、Collect News文章内容对象是特殊的。寻找刚刚被别人发布的新闻文章内容作为采集对象,在被太多人转发之前先采集,但新闻文章内容的前提是具有超前性、新鲜性和代表性,而不是一些陈词滥调的话题,否则对用户毫无价值。既然是收新闻文章content,自然比原创简单多了,编辑news文章content也不会花太多时间。不要花在这个时候节省的时间。所以,毕竟采集到的新闻文章内容没有原创那么直接,所以你要多找几个新闻文章内容同时采集,弥补蜘蛛的空虚。

二、Collect News文章Content 不采集头条新闻。大家都知道读文章的时候,首先看的就是标题。对于网站优化的搜索引擎,标题也有一定的权重。采集的新闻文章的内容有一定的长度,不能改动太多,但标题只有短短的几个字。修改起来相对容易。标题需要修改,改成原来的标题。原因很简单。当看到相同的实质性新闻文章与文章的内容完全不同时,会给读者一些误解,认为这两个新闻文章内容相同,相反,即使是新闻文章内容一样,标题完全不一样,也会给人新鲜感,不容易被人发现。

三、对news文章的内容进行适当的调整。我试图采集新闻文章 内容给我的网站 站长。细心的人难免会发现直接复制的news文章内容还是有格式问题的,因为一些精明的原创人想要防止News文章内容被采集,通常会在news文章内容中加入一些隐藏格式,甚至在图片的ALT信息中都标注了版权。如果不注意,自然会被搜索引擎识别为抄袭。那么对网站的伤害不言而喻。因此,采集的news文章内容必须进行格式化,英文格式的标点符号必须进行转换。另外,可以在news文章content中添加一些图片,让news文章内容更加丰富,如果news文章内容本身有图片,就不要直接复制了。保存并上传到网站,加上自己的ALT信息,可以让新闻文章内容的采集更有价值。

总之,网站采集新闻文章content 也不是完全没用。关键取决于你如何采集它。只要能灵活使用采集到的news文章content,就可以给网站带来一定的好处,但是站长需要注意一定的采集方法。返回搜狐查看更多

文章采集完(让我们从两个常见的内容采集工具开始:优采云采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-08-29 21:07

让我们从两个常见的内容开始采集tools:

(1)优采云采集工具:操作比较简单,免费版可以满足新手站长数据挖掘的需求,但是采集数据的推导需要整合,而且更多重要功能是智能采集,不用写太复杂的规则。

(2)优采云采集器:国产除尘软件老牌子。所以支持cms系统采集的插件很多,比如:织梦文章 采集、WordPress信息采集、Zblog数据采集等,支架的扩展性比较大,但需要一定的技术力量。

那么,对于文章的采集,我们应该注意哪些问题?

1、新站删除了数据采集

我们知道网站发布初期有一个评估期。如果我们在网站开头使用采集到的内容,将会对网站的评分产生影响。 文章很容易被放入低质量的库中,并且会出现一个普遍现象:与收录没有排名。

为此,新版网站尽量保持原有内容在线,页面内容未完全索引时,无需盲目提交,或者如果要提交,则需要采用一定的策略。

2、权重网站采集内容

我们知道搜索引擎不喜欢封闭状态。他们喜欢的网站 不仅有导入链接,还有一些导出链接,让这个生态系统更具相关性。

为此,您的网站积累了一定的权重后,可以通过版权链接适当采集相关内容,需要注意:

(1)保证内容集合对站内用户有一定的推荐价值,是解决用户需求的好方法。

(2)工业公文,heavy网站,知名专家推荐采集内容。

3、to avoid采集全站内容

说到这个问题,很多人很容易质疑飓风算法对收购的严厉打击,但为什么权威网站不在打击范围之内?

这和搜索引擎的性质有关:为了满足用户的需求,网站对优质内容传播的影响也比较重要。

对于中小网站,在我们拥有独特的属性和影响力之前,我们应该尽量避免采集的大量内容。

提醒:随着熊掌的上线和原创protection的引入,百度仍会努力调整和平衡原创content和authority网站的排名。原则上,应该更倾向于对原创网站进行排名。

4、如果网站内容采集被处罚,我们该怎么办?

飓风算法非常人性化。它只会惩罚采集 列,但对同一站点的其他列几乎没有影响。

所以,解决方法很简单,只需要删除采集的内容并设置404页面,然后在百度搜索资源平台提交死链接->网站Support->资料介绍->死链接提交栏。如果您发现网站的体重恢复缓慢,可以在反馈中心反馈。

总结:内容依然适用于王。关注熊掌号,你会发现2019年百度会加大对原创内容的支持,尽量避免采集内容。 查看全部

文章采集完(让我们从两个常见的内容采集工具开始:优采云采集)

让我们从两个常见的内容开始采集tools:

(1)优采云采集工具:操作比较简单,免费版可以满足新手站长数据挖掘的需求,但是采集数据的推导需要整合,而且更多重要功能是智能采集,不用写太复杂的规则。

(2)优采云采集器:国产除尘软件老牌子。所以支持cms系统采集的插件很多,比如:织梦文章 采集、WordPress信息采集、Zblog数据采集等,支架的扩展性比较大,但需要一定的技术力量。

那么,对于文章的采集,我们应该注意哪些问题?

1、新站删除了数据采集

我们知道网站发布初期有一个评估期。如果我们在网站开头使用采集到的内容,将会对网站的评分产生影响。 文章很容易被放入低质量的库中,并且会出现一个普遍现象:与收录没有排名。

为此,新版网站尽量保持原有内容在线,页面内容未完全索引时,无需盲目提交,或者如果要提交,则需要采用一定的策略。

2、权重网站采集内容

我们知道搜索引擎不喜欢封闭状态。他们喜欢的网站 不仅有导入链接,还有一些导出链接,让这个生态系统更具相关性。

为此,您的网站积累了一定的权重后,可以通过版权链接适当采集相关内容,需要注意:

(1)保证内容集合对站内用户有一定的推荐价值,是解决用户需求的好方法。

(2)工业公文,heavy网站,知名专家推荐采集内容。

3、to avoid采集全站内容

说到这个问题,很多人很容易质疑飓风算法对收购的严厉打击,但为什么权威网站不在打击范围之内?

这和搜索引擎的性质有关:为了满足用户的需求,网站对优质内容传播的影响也比较重要。

对于中小网站,在我们拥有独特的属性和影响力之前,我们应该尽量避免采集的大量内容。

提醒:随着熊掌的上线和原创protection的引入,百度仍会努力调整和平衡原创content和authority网站的排名。原则上,应该更倾向于对原创网站进行排名。

4、如果网站内容采集被处罚,我们该怎么办?

飓风算法非常人性化。它只会惩罚采集 列,但对同一站点的其他列几乎没有影响。

所以,解决方法很简单,只需要删除采集的内容并设置404页面,然后在百度搜索资源平台提交死链接->网站Support->资料介绍->死链接提交栏。如果您发现网站的体重恢复缓慢,可以在反馈中心反馈。

总结:内容依然适用于王。关注熊掌号,你会发现2019年百度会加大对原创内容的支持,尽量避免采集内容。

这是快速入门爬虫1-0基础采集入门知识学习

采集交流 • 优采云 发表了文章 • 0 个评论 • 314 次浏览 • 2021-08-26 18:06

欢迎来到小白的数据梦工厂。很高兴你对爬虫感兴趣,想学习爬虫,或者想采集一些网络数据。

先自我介绍一下。我是优采云采集器的创始人刘宝强。 优采云是全球领先的网络数据采集平台,每天为全球70万家企业和个人提供采集1亿条数据。恭喜您在众多开始使用爬虫的方式中选择了 优采云。这是一个非常好的起点。你从一开始就站在巨人的肩膀上!

阅读这篇文章大约需要 15 分钟。

这是Quick Start Crawler的第二部分,第一个链接:Quick Start Crawler 1-0 Basics采集Beginner Knowledge

本系列文章将带领你从0基础开始,一步一步,从采集一个简单的网页,到复杂的列表,多页数据,Ajax页面,瀑布流等等,直到应对常见封IP,验证码等防采集措施,包括采集淘宝,京东,微信,大众点评等热门网站。由浅入深,循序渐进的深入网页数据采集领域,相信认真学完本系列,你也会成为采集大神,有能力把互联网变成自己的数据库(这一段提到了Ajax等专业数据,你可能不懂,但有个好消息:到目前为止你不需要了解这些技术概念)。

要学习本内容,首先需要掌握以下知识:

学习了第一篇:Quick Start Crawler-0 Basic 采集Beginner Knowledge,这意味着你了解了基础知识并成功安装了优采云采集器,在第一篇文章解释中有详细说明。

截止本文发布时,八爪鱼采集器的最新版本是7.1.8,下载地址是:http://www.bazhuayu.com/download

学习本内容后,您将掌握以下内容:

了解如何采集list 数据。学习如何翻页实现多页数据采集。

第一篇我们采集成功采集一条数据,你可能觉得采集一条数据没用,采集一条数据是手动复制最快的方式,可能几十以内件数 可以手动复制。在实际应用场景中,我们经常需要采集数百、数千甚至数百万的数据。所以,第一篇文章的意义在于学习如何使用软件工具实现自动化采集。

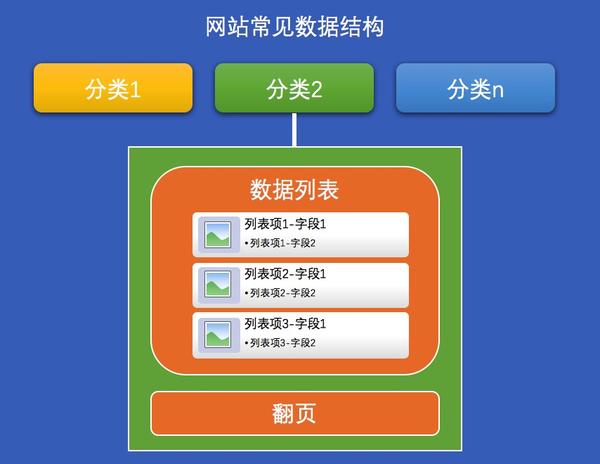

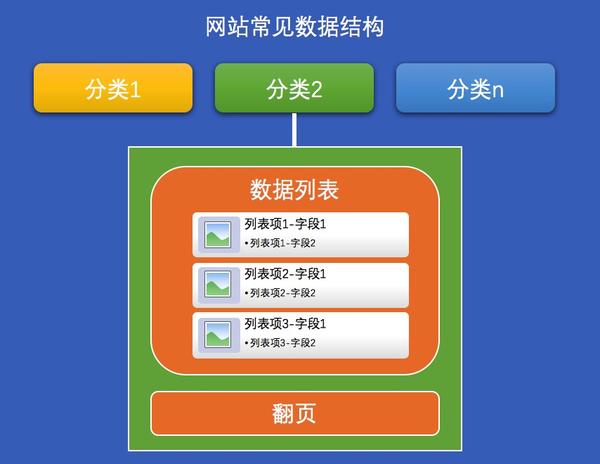

在真实场景中,大部分网站数据可能是这样的(如下图):

一个网站有很多类别,每个类别都有很多数据。通常,每个类别都是一个页面,其中收录一个列表或表格以及一个翻页功能。以知名的京东商城为例。京东有很多产品品类(categories),每个品类(比如手机)都有一个手机数据列表(data list)。该列表页收录60款手机的基本数据。每个手机(列表项)都有价格、标题、销量(字段)等多个具体信息,页面底部有一个翻页链接区。您可以点击下一页,在第二页查看其他60款手机的基本数据。

常见的网站数据结构图

上面提到了几个概念,我们采集data时经常用到的几个概念:分类、列表、数据项、数据字段、翻页;如果你看到一个网站,你可以在脑海中构建它 当使用网站数据结构时,采集变得非常容易。

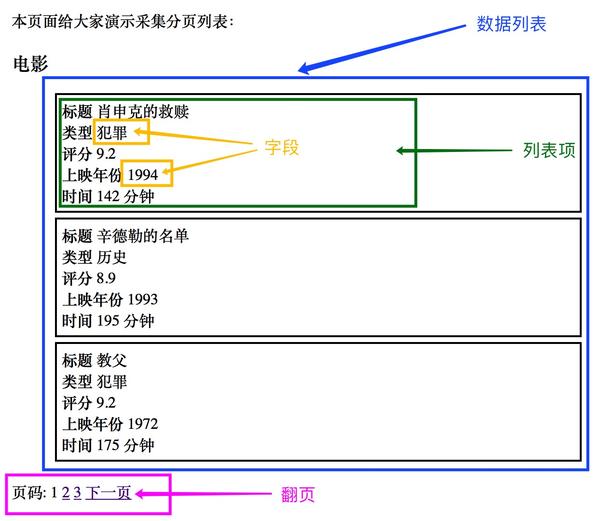

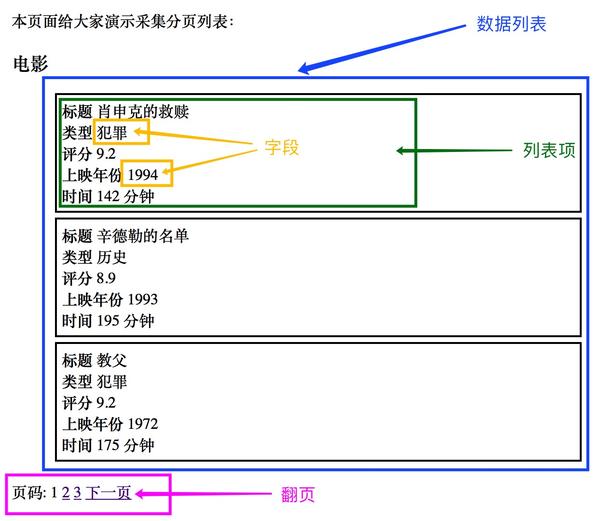

这里我为大家准备了一个例子网站:Demo网站-电影数据分类,网址:/guide/demo/genremoviespage1.html,大家可以对比一下上面常见的网站数据结构图来看看这个网站,是不是很像? ?

示例网站截图(带有网站数据结构标记)

如果我们不使用工具,手动复制完成的数据采集,我们肯定会这样做:

在浏览器中打开这个网站。复制第一部电影的数据:标题肖申克的救赎类型犯罪评级9.2 发行年份1994 时间142 分钟。粘贴到 Excel 中并另存为 5 列。重复上面的步骤 2,直到您复制了第一页上的 3 部电影的数据。点击翻页区的“下一页”链接,重复步骤2和3,然后再次点击“下一页”,重复直到到达最后一页(最后一页没有“下一页”链接) .

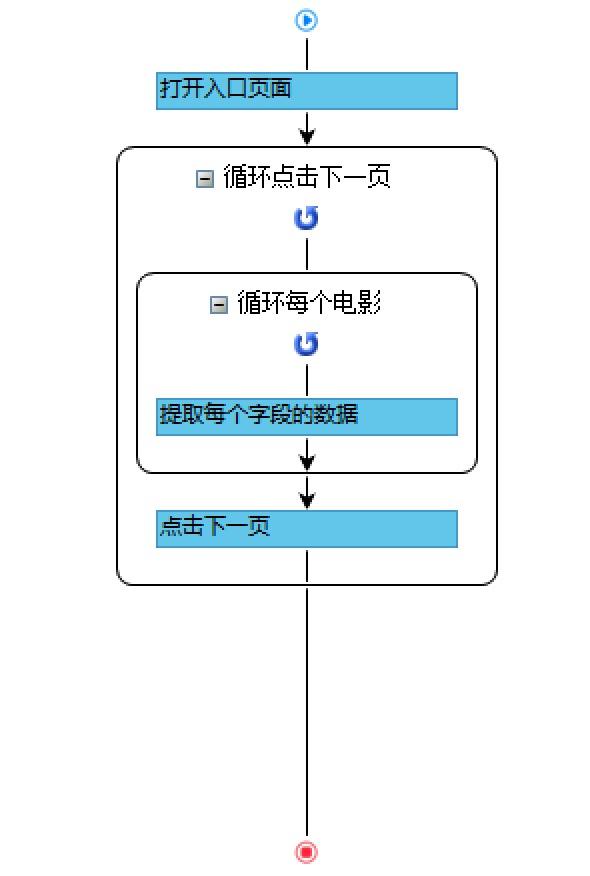

那么优采云工具怎么用呢?还记得第一篇提到的优采云采集核心原理吗?

优采云采集的核心原理是模拟人们浏览网页和复制数据的行为。通过记录和模拟人们的一系列上网行为,他们可以代替人眼浏览网页,手动复制网页数据。对来自网页采集的数据进行自动化处理,然后重复一系列设定的动作流程,实现采集海量数据的全自动处理。

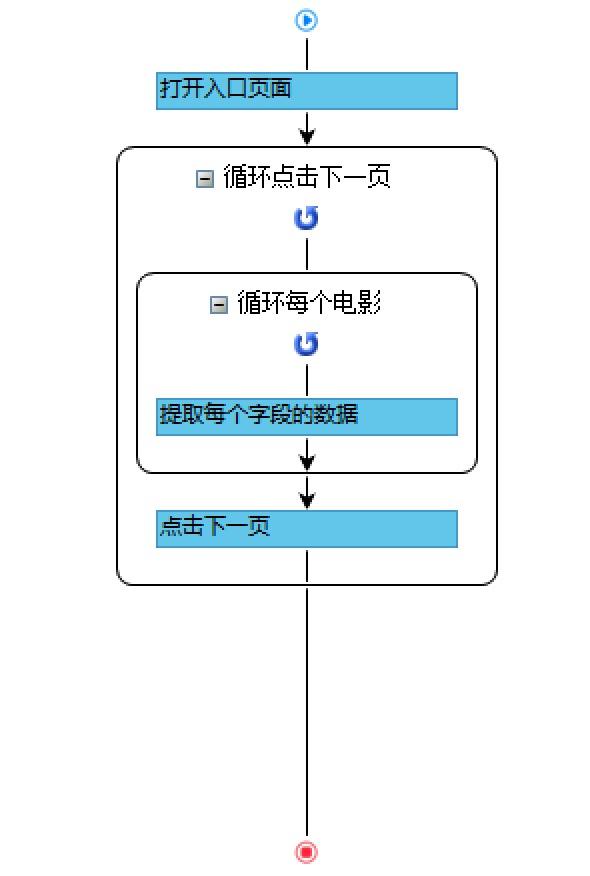

你可能已经想到了怎么做,别着急,让我们试着把我们的想法画成一个流程图,它应该是这样的:

我来解释一下这个流程图的具体步骤:

蓝色方块代表一些步骤,黑色圆角矩形代表我们需要重复的一个或多个步骤。

打开这个网站分类数据录入页面,就是刚才的示例网址。接下来是需要重复的步骤:重复点击下一页,黑色矩形线框中的部分需要重复。里面还有一个需要重复的步骤:循环每部电影,同样的道理,我们看里面,有一个蓝色的步骤:提取每个字段的数据,这个现在要做,让优采云Tools自动提取每个字段。执行完最后一个蓝色步骤后,此时需要重复这个蓝色步骤,直到自动提取出第一页的三部电影的数据。至此,“循环每部电影”的步骤就完成了。然后我们执行如下蓝色步骤:点击下一页,这样网页会跳转到第2页,我们重复步骤2、3,然后“点击下一页”,以此类推,直到采集完最后一页数据,此时网页上没有“下一页”链接,“循环点击下一页”以外的重复步骤就结束了,整个过程就结束了。

仔细对照优采云工具采集的使用流程图,仔细对比手动复制数据的4个步骤,你会发现它们非常相似,可以说是完全相同的过程。这再次说明优采云就像一个机器人,模拟人类的思维和上网行为以及复制数据的过程。虽然每个网站都不同,但好消息是:任何复杂的网站都可以用这个简单的想法来做,想想人们是怎么做的,然后在优采云中设置相应的工作流,你可以实现任何网站网站采集。这就是优采云能够跟上变化,能够采集any网站的秘诀。

看到这里,也许你已经迫不及待要实际去做了,验证一下我们的想法,我们来看看如何在实践中去做:

打开优采云采集器,点击“自定义采集”按钮→点击左上角“新建任务”按钮进入任务配置页面,然后输入网址(/guide/demo /genremoviespage1.html )→保存网址,系统进入流程设计页面,自动打开输入的网址。

操作录屏-第一步

2. 打开网页后,随着鼠标的移动,有蓝色背景指示内容。 优采云内置了自己专门为采集数据开发的浏览器。这款浏览器除了可以显示网页之外,还增加了很多功能来支持采集。其中之一是当鼠标在不同的内容上移动时,相应的内容会自动标记为蓝色背景。当用户点击鼠标时,该区域将被选中并标记为绿色,并弹出操作提示框。这里优采云已经自动识别出我们选择的区域收录多个数字字段(子元素),并用红色虚线框标记(表示预选),我们点击第一个选项“选择子元素”,多个刚刚预选的数据字段被正式选中并标记为绿色,这些字段也会在提示界面的表格中显示。然后优采云提醒我们:找到了3组相似的元素,也就是自动找到了另外2部电影的数据,也是用红色虚线框预选的,我们选择第一个选项“全选”,然后选择它是所有电影的数据。

操作录屏-步骤2

在第二步中,我们接触到了几个新的东西:子元素、智能提示框、各种颜色选择提示。如果您有兴趣,可以阅读下面的详细说明。当然,你可以跳到第一个3步操作。

智能提醒框:

为了记录采集数据的步骤,优采云在用户选择要操作的网页内容时会要求用户选择要进行的操作。比如用户选择一个链接,可以选择提取链接的文字、URL链接,或者点击这个链接等。优采云的智能提示不仅可以让用户选择操作,还可以预测用户的操作最有可能的下一个操作。通过对网页数据的智能分析,优采云会自动发现数据字段和类似的数据项,指导用户操作。 4是不是4很聪明,很贴心?

选择提示颜色:

蓝色表示鼠标当前放置在哪个内容区域。

绿色表示我们点击了所选内容。

红色虚线表示系统智能识别并预测您要选择的内容。

子元素:

当我们选择一个收录多个数据字段的区域时,优采云将选中的区域称为“元素(英文Element,这是一个技术术语)”,每个数据字段称为一个“子元素”,元素可能收录多个“子元素”。

3. 在上一步中,我们已经选择了所有数据。在我们确定采集这些字段之前,让我们先检查一下表格。您会发现标题本身也被提取为一个字段。事实上,我们只需要真正的标题。 , 标题中不需要两个字,所以我们可以直接删除提示框表单中的“字段1”,同理删除其他多余的字段,然后修改我们想要的字段的字段名。点击采集确认数据字段。

操作录屏-第三步

4.我们现在采集有第一页的所有数据,一共3页,然后我们设置翻页,点击下面的“下一页”按钮,优采云自动识别这是next 对于一页链接,我们选择“循环点击下一页”的选项,这样系统就会翻页,每页采集直到最后一页。点击启动采集,在弹出的窗口中选择“启动本地采集”,会弹出一个窗口,继续采集。

操作录屏-第4步

总结:

恭喜!您已经成功地采集 获得了电影网站 的所有数据,以此类推,您将能够以同样的方式采集 任何收录列表、表格和页面的网站,并且您在通往采集 的道路已经实现了另一个里程碑。以后我们会继续学习更多的技能,一步步成为采集大神。

如果有什么问题或者想法想和我交流,请在下方评论区留言。也可以关注我的知乎与我互动:点击关注“刘宝强的知乎”。同时欢迎关注我的知乎专栏,获取文章新通知:点击关注“小白的数据梦工厂” 查看全部

这是快速入门爬虫1-0基础采集入门知识学习

欢迎来到小白的数据梦工厂。很高兴你对爬虫感兴趣,想学习爬虫,或者想采集一些网络数据。

先自我介绍一下。我是优采云采集器的创始人刘宝强。 优采云是全球领先的网络数据采集平台,每天为全球70万家企业和个人提供采集1亿条数据。恭喜您在众多开始使用爬虫的方式中选择了 优采云。这是一个非常好的起点。你从一开始就站在巨人的肩膀上!

阅读这篇文章大约需要 15 分钟。

这是Quick Start Crawler的第二部分,第一个链接:Quick Start Crawler 1-0 Basics采集Beginner Knowledge

本系列文章将带领你从0基础开始,一步一步,从采集一个简单的网页,到复杂的列表,多页数据,Ajax页面,瀑布流等等,直到应对常见封IP,验证码等防采集措施,包括采集淘宝,京东,微信,大众点评等热门网站。由浅入深,循序渐进的深入网页数据采集领域,相信认真学完本系列,你也会成为采集大神,有能力把互联网变成自己的数据库(这一段提到了Ajax等专业数据,你可能不懂,但有个好消息:到目前为止你不需要了解这些技术概念)。

要学习本内容,首先需要掌握以下知识:

学习了第一篇:Quick Start Crawler-0 Basic 采集Beginner Knowledge,这意味着你了解了基础知识并成功安装了优采云采集器,在第一篇文章解释中有详细说明。

截止本文发布时,八爪鱼采集器的最新版本是7.1.8,下载地址是:http://www.bazhuayu.com/download

学习本内容后,您将掌握以下内容:

了解如何采集list 数据。学习如何翻页实现多页数据采集。

第一篇我们采集成功采集一条数据,你可能觉得采集一条数据没用,采集一条数据是手动复制最快的方式,可能几十以内件数 可以手动复制。在实际应用场景中,我们经常需要采集数百、数千甚至数百万的数据。所以,第一篇文章的意义在于学习如何使用软件工具实现自动化采集。

在真实场景中,大部分网站数据可能是这样的(如下图):

一个网站有很多类别,每个类别都有很多数据。通常,每个类别都是一个页面,其中收录一个列表或表格以及一个翻页功能。以知名的京东商城为例。京东有很多产品品类(categories),每个品类(比如手机)都有一个手机数据列表(data list)。该列表页收录60款手机的基本数据。每个手机(列表项)都有价格、标题、销量(字段)等多个具体信息,页面底部有一个翻页链接区。您可以点击下一页,在第二页查看其他60款手机的基本数据。

常见的网站数据结构图

上面提到了几个概念,我们采集data时经常用到的几个概念:分类、列表、数据项、数据字段、翻页;如果你看到一个网站,你可以在脑海中构建它 当使用网站数据结构时,采集变得非常容易。

这里我为大家准备了一个例子网站:Demo网站-电影数据分类,网址:/guide/demo/genremoviespage1.html,大家可以对比一下上面常见的网站数据结构图来看看这个网站,是不是很像? ?

示例网站截图(带有网站数据结构标记)

如果我们不使用工具,手动复制完成的数据采集,我们肯定会这样做:

在浏览器中打开这个网站。复制第一部电影的数据:标题肖申克的救赎类型犯罪评级9.2 发行年份1994 时间142 分钟。粘贴到 Excel 中并另存为 5 列。重复上面的步骤 2,直到您复制了第一页上的 3 部电影的数据。点击翻页区的“下一页”链接,重复步骤2和3,然后再次点击“下一页”,重复直到到达最后一页(最后一页没有“下一页”链接) .

那么优采云工具怎么用呢?还记得第一篇提到的优采云采集核心原理吗?

优采云采集的核心原理是模拟人们浏览网页和复制数据的行为。通过记录和模拟人们的一系列上网行为,他们可以代替人眼浏览网页,手动复制网页数据。对来自网页采集的数据进行自动化处理,然后重复一系列设定的动作流程,实现采集海量数据的全自动处理。

你可能已经想到了怎么做,别着急,让我们试着把我们的想法画成一个流程图,它应该是这样的:

我来解释一下这个流程图的具体步骤:

蓝色方块代表一些步骤,黑色圆角矩形代表我们需要重复的一个或多个步骤。

打开这个网站分类数据录入页面,就是刚才的示例网址。接下来是需要重复的步骤:重复点击下一页,黑色矩形线框中的部分需要重复。里面还有一个需要重复的步骤:循环每部电影,同样的道理,我们看里面,有一个蓝色的步骤:提取每个字段的数据,这个现在要做,让优采云Tools自动提取每个字段。执行完最后一个蓝色步骤后,此时需要重复这个蓝色步骤,直到自动提取出第一页的三部电影的数据。至此,“循环每部电影”的步骤就完成了。然后我们执行如下蓝色步骤:点击下一页,这样网页会跳转到第2页,我们重复步骤2、3,然后“点击下一页”,以此类推,直到采集完最后一页数据,此时网页上没有“下一页”链接,“循环点击下一页”以外的重复步骤就结束了,整个过程就结束了。

仔细对照优采云工具采集的使用流程图,仔细对比手动复制数据的4个步骤,你会发现它们非常相似,可以说是完全相同的过程。这再次说明优采云就像一个机器人,模拟人类的思维和上网行为以及复制数据的过程。虽然每个网站都不同,但好消息是:任何复杂的网站都可以用这个简单的想法来做,想想人们是怎么做的,然后在优采云中设置相应的工作流,你可以实现任何网站网站采集。这就是优采云能够跟上变化,能够采集any网站的秘诀。

看到这里,也许你已经迫不及待要实际去做了,验证一下我们的想法,我们来看看如何在实践中去做:

打开优采云采集器,点击“自定义采集”按钮→点击左上角“新建任务”按钮进入任务配置页面,然后输入网址(/guide/demo /genremoviespage1.html )→保存网址,系统进入流程设计页面,自动打开输入的网址。

操作录屏-第一步

2. 打开网页后,随着鼠标的移动,有蓝色背景指示内容。 优采云内置了自己专门为采集数据开发的浏览器。这款浏览器除了可以显示网页之外,还增加了很多功能来支持采集。其中之一是当鼠标在不同的内容上移动时,相应的内容会自动标记为蓝色背景。当用户点击鼠标时,该区域将被选中并标记为绿色,并弹出操作提示框。这里优采云已经自动识别出我们选择的区域收录多个数字字段(子元素),并用红色虚线框标记(表示预选),我们点击第一个选项“选择子元素”,多个刚刚预选的数据字段被正式选中并标记为绿色,这些字段也会在提示界面的表格中显示。然后优采云提醒我们:找到了3组相似的元素,也就是自动找到了另外2部电影的数据,也是用红色虚线框预选的,我们选择第一个选项“全选”,然后选择它是所有电影的数据。

操作录屏-步骤2

在第二步中,我们接触到了几个新的东西:子元素、智能提示框、各种颜色选择提示。如果您有兴趣,可以阅读下面的详细说明。当然,你可以跳到第一个3步操作。

智能提醒框:

为了记录采集数据的步骤,优采云在用户选择要操作的网页内容时会要求用户选择要进行的操作。比如用户选择一个链接,可以选择提取链接的文字、URL链接,或者点击这个链接等。优采云的智能提示不仅可以让用户选择操作,还可以预测用户的操作最有可能的下一个操作。通过对网页数据的智能分析,优采云会自动发现数据字段和类似的数据项,指导用户操作。 4是不是4很聪明,很贴心?

选择提示颜色:

蓝色表示鼠标当前放置在哪个内容区域。

绿色表示我们点击了所选内容。

红色虚线表示系统智能识别并预测您要选择的内容。

子元素:

当我们选择一个收录多个数据字段的区域时,优采云将选中的区域称为“元素(英文Element,这是一个技术术语)”,每个数据字段称为一个“子元素”,元素可能收录多个“子元素”。

3. 在上一步中,我们已经选择了所有数据。在我们确定采集这些字段之前,让我们先检查一下表格。您会发现标题本身也被提取为一个字段。事实上,我们只需要真正的标题。 , 标题中不需要两个字,所以我们可以直接删除提示框表单中的“字段1”,同理删除其他多余的字段,然后修改我们想要的字段的字段名。点击采集确认数据字段。

操作录屏-第三步

4.我们现在采集有第一页的所有数据,一共3页,然后我们设置翻页,点击下面的“下一页”按钮,优采云自动识别这是next 对于一页链接,我们选择“循环点击下一页”的选项,这样系统就会翻页,每页采集直到最后一页。点击启动采集,在弹出的窗口中选择“启动本地采集”,会弹出一个窗口,继续采集。

操作录屏-第4步

总结:

恭喜!您已经成功地采集 获得了电影网站 的所有数据,以此类推,您将能够以同样的方式采集 任何收录列表、表格和页面的网站,并且您在通往采集 的道路已经实现了另一个里程碑。以后我们会继续学习更多的技能,一步步成为采集大神。

如果有什么问题或者想法想和我交流,请在下方评论区留言。也可以关注我的知乎与我互动:点击关注“刘宝强的知乎”。同时欢迎关注我的知乎专栏,获取文章新通知:点击关注“小白的数据梦工厂”

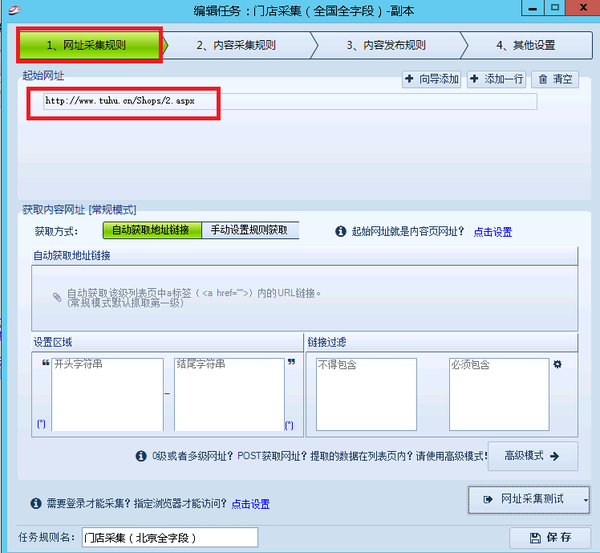

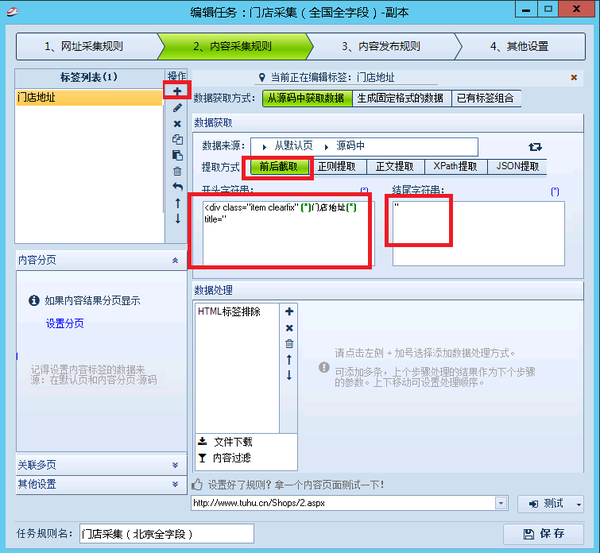

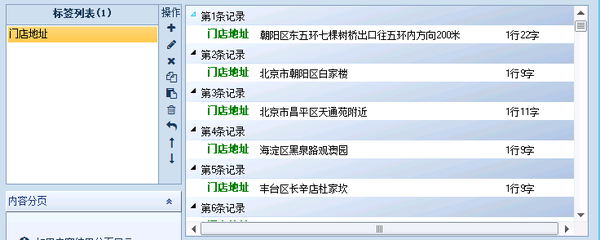

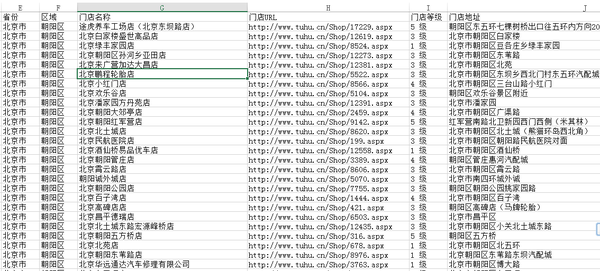

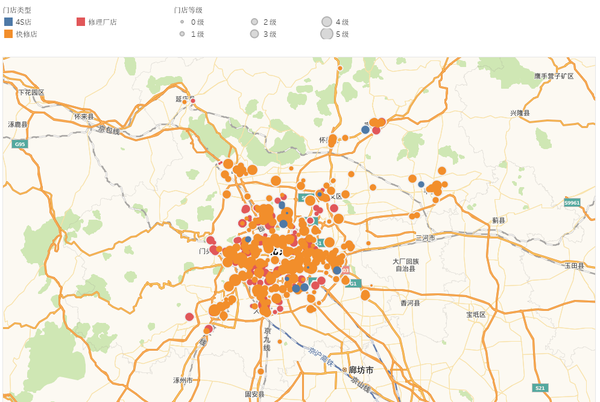

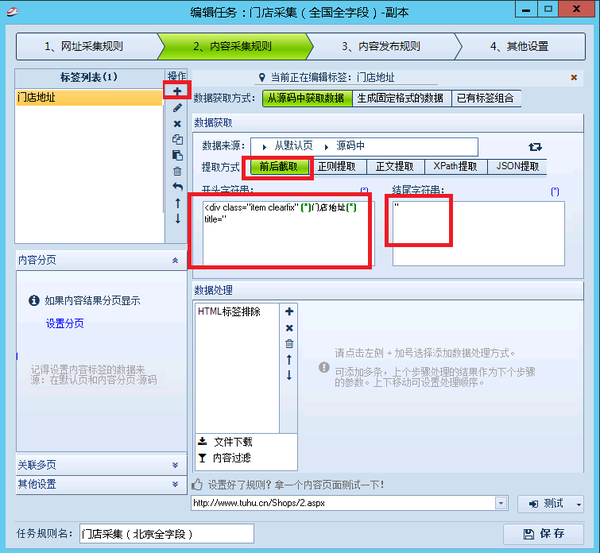

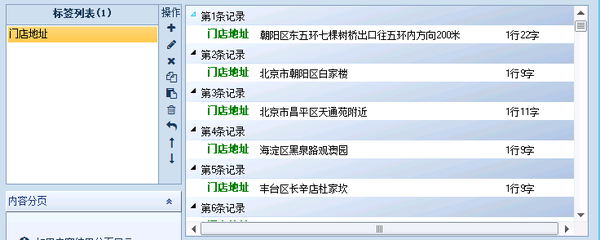

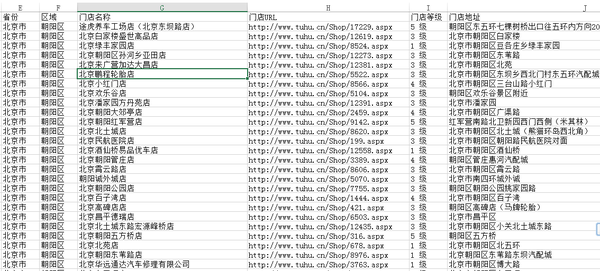

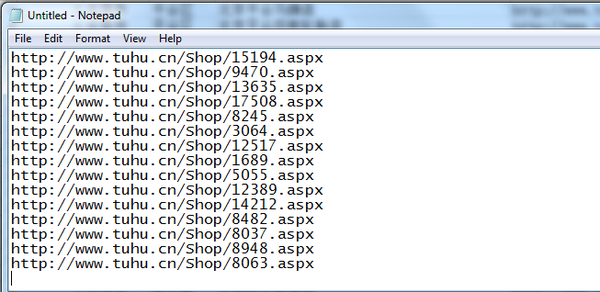

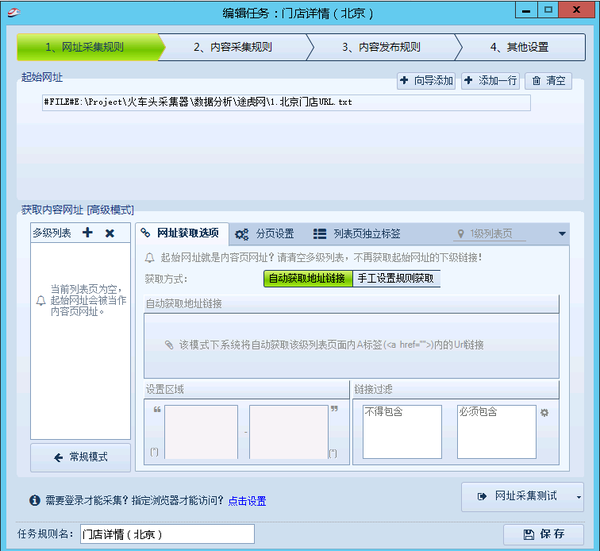

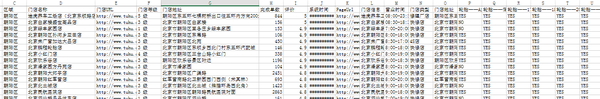

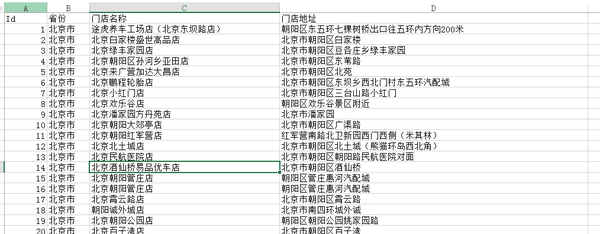

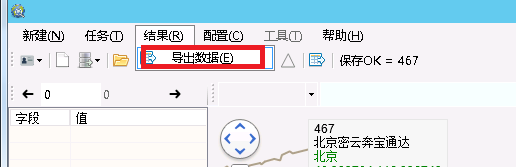

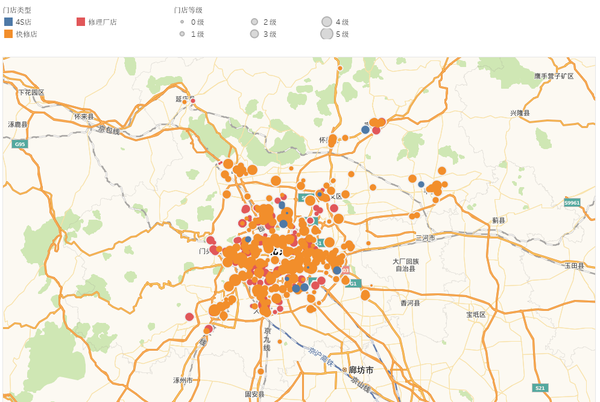

接下来很简单?对就是这么简单!就去优采云里再配置下吧

采集交流 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-08-26 18:04

”

容易吗?就是这么简单!接下来去优采云重新配置

根据工具的配置向导添加要爬取的网址

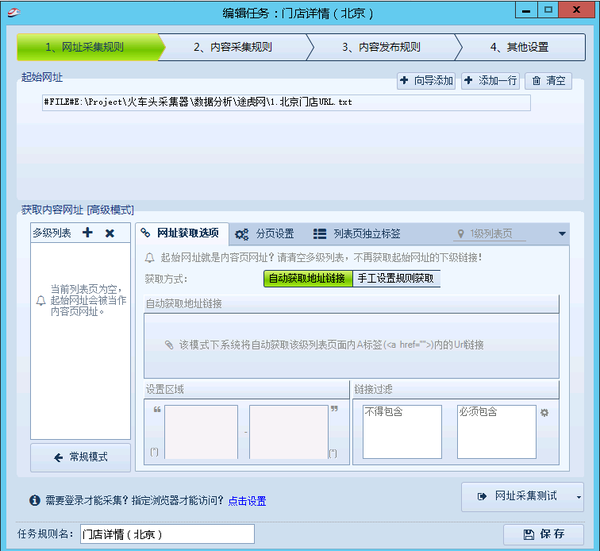

下一步是在内容采集规则中创建您需要采集的标签逻辑。不说了,看下图,进入之前的逻辑。

至此,一个字段的抽取逻辑配置完成。我们来看看效果?所有地址采集 都到了吗?其他字段配置方法相同,这里不再赘述。

接下来,将数据库中的数据导出,放到excel预览中,如下所示。为什么要导入到excel中,因为我们还需要根据店铺网址爬取店铺的详细数据(其实高手可以通过一个爬取任务来完成这两个任务) 部分数据的爬取,我来介绍一下如何配置以后有机会再说)。

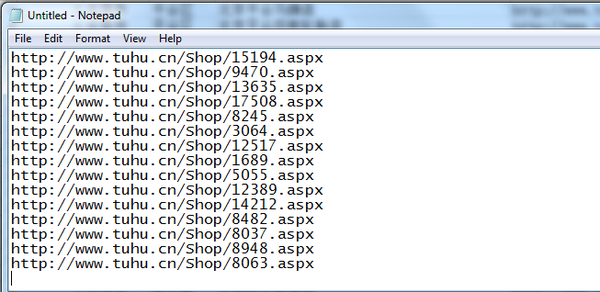

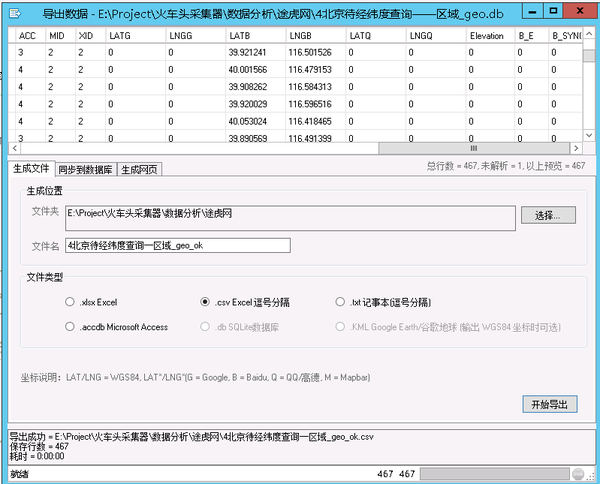

第二步:爬取店铺详情数据。将第一步爬取的“店铺网址”的所有数据保存成txt文本

URL采集rule 的 URL 可以改成保存的文本,然后配置一堆规则。 . . . .

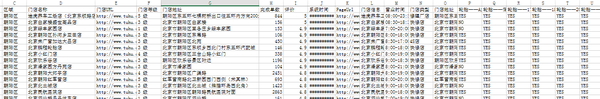

采集 详细数据整理好后,通过URL对两个表做JOIN(我用的是Mysql,所以做了类似的语句)

到此为止,我们已经把结果再次导出到excel了(你可以继续在数据库中操作,你喜欢吗)

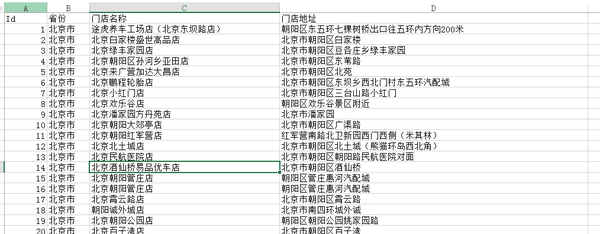

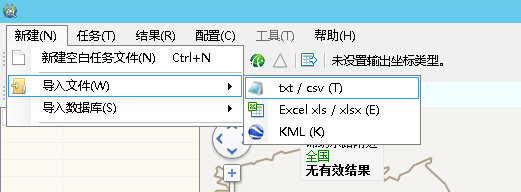

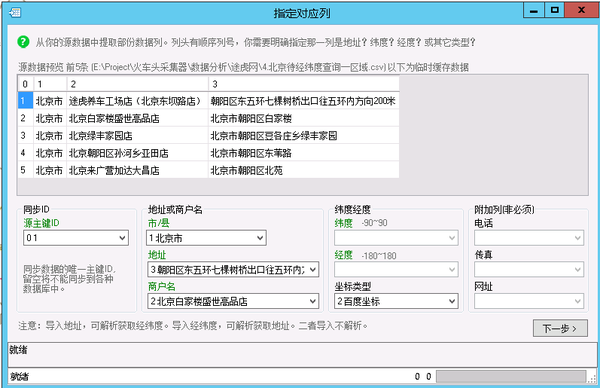

第三步,采集经纬度信息。 XGeocoding 工具在这里。

首先,您需要为 XGeocoding 准备一个数据源。为了使提取的经纬度更加准确,这里需要4个字段

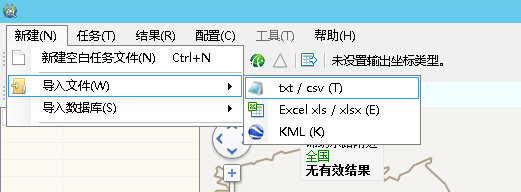

通过“新建”→“导入文件”→“txt/csv”导入准备好的数据

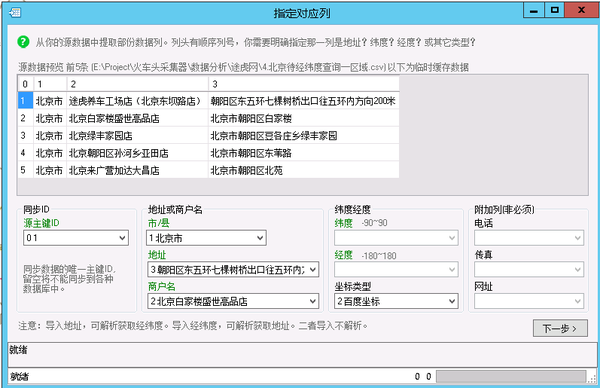

选择字段 0 为“同步 ID”,字段 1 为“市/县”,字段 2 为“企业名称”,字段 3 为“地址”。坐标类型选择“百度”。当然,你有其他地图的KEY,也可以使用其他地图源。

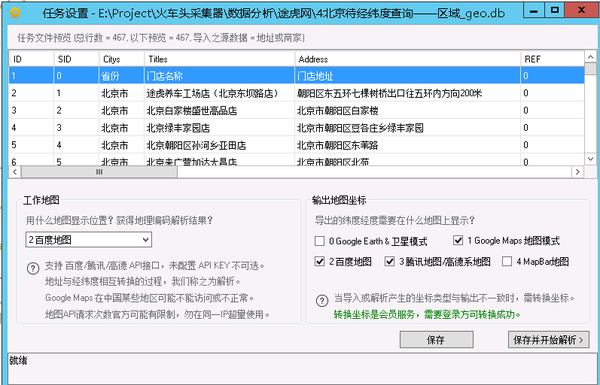

下一步后,您将被要求选择“工作地图”并输出地图坐标。在这里您可以根据实际需要进行选择。工作图需要配置API KEY才能调用(去他们的开发者门户申请)

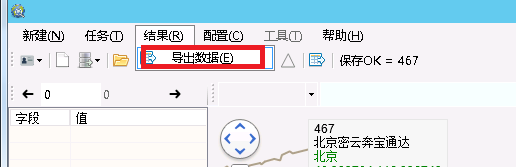

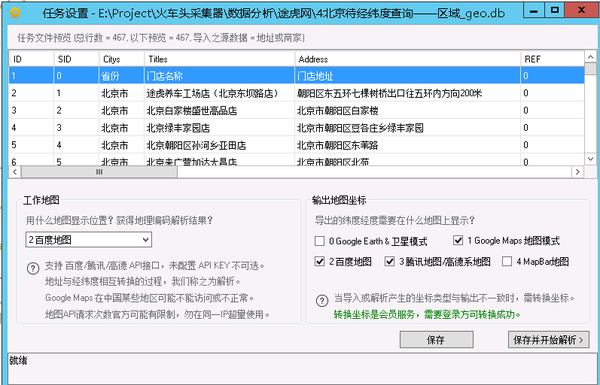

然后使用“结果”→“导出数据”预览已经采集的经纬度数据,然后导出。

清理导出的数据,保留ID、经纬度。只需通过ID和第二步数据JOIN即可。

最后,我们通过 tableau 预览数据。

总结:

本文以采集北京区土虎门门店信息为例,对数据采集tool操作做一个基础演示(部分细节不解释,不明白的可以留言) ,借助工具,即使不是IT,也可以自己爬取在线数据。不过还是有几点要提醒大家:

1.Tools 一定有局限性,不是万能的。

2.采集的结果也会有一定的偏差。这时候就需要采取一些手段和方法来避免偏差。例如,在本文中,我们使用省份、地址和商店名称进行多数据验证。即便如此,仍然会有异常数据。由于地址本身同名或相近,当输入信息不足时,仍会出现错误。如果需要进一步完善data采集 查看全部

接下来很简单?对就是这么简单!就去优采云里再配置下吧

”

容易吗?就是这么简单!接下来去优采云重新配置

根据工具的配置向导添加要爬取的网址

下一步是在内容采集规则中创建您需要采集的标签逻辑。不说了,看下图,进入之前的逻辑。

至此,一个字段的抽取逻辑配置完成。我们来看看效果?所有地址采集 都到了吗?其他字段配置方法相同,这里不再赘述。

接下来,将数据库中的数据导出,放到excel预览中,如下所示。为什么要导入到excel中,因为我们还需要根据店铺网址爬取店铺的详细数据(其实高手可以通过一个爬取任务来完成这两个任务) 部分数据的爬取,我来介绍一下如何配置以后有机会再说)。

第二步:爬取店铺详情数据。将第一步爬取的“店铺网址”的所有数据保存成txt文本

URL采集rule 的 URL 可以改成保存的文本,然后配置一堆规则。 . . . .

采集 详细数据整理好后,通过URL对两个表做JOIN(我用的是Mysql,所以做了类似的语句)

到此为止,我们已经把结果再次导出到excel了(你可以继续在数据库中操作,你喜欢吗)

第三步,采集经纬度信息。 XGeocoding 工具在这里。

首先,您需要为 XGeocoding 准备一个数据源。为了使提取的经纬度更加准确,这里需要4个字段

通过“新建”→“导入文件”→“txt/csv”导入准备好的数据

选择字段 0 为“同步 ID”,字段 1 为“市/县”,字段 2 为“企业名称”,字段 3 为“地址”。坐标类型选择“百度”。当然,你有其他地图的KEY,也可以使用其他地图源。

下一步后,您将被要求选择“工作地图”并输出地图坐标。在这里您可以根据实际需要进行选择。工作图需要配置API KEY才能调用(去他们的开发者门户申请)

然后使用“结果”→“导出数据”预览已经采集的经纬度数据,然后导出。

清理导出的数据,保留ID、经纬度。只需通过ID和第二步数据JOIN即可。

最后,我们通过 tableau 预览数据。

总结:

本文以采集北京区土虎门门店信息为例,对数据采集tool操作做一个基础演示(部分细节不解释,不明白的可以留言) ,借助工具,即使不是IT,也可以自己爬取在线数据。不过还是有几点要提醒大家:

1.Tools 一定有局限性,不是万能的。

2.采集的结果也会有一定的偏差。这时候就需要采取一些手段和方法来避免偏差。例如,在本文中,我们使用省份、地址和商店名称进行多数据验证。即便如此,仍然会有异常数据。由于地址本身同名或相近,当输入信息不足时,仍会出现错误。如果需要进一步完善data采集

系统默认的标签提升采集性能是什么?-八维教育

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-08-26 00:06

功能介绍:1、support文章内容分页采集;2、support forum采集3、support UTF-8转GB2312,采集内容字符格式可以是UTF-8目标; 4、 支持在本地保存文章 内容; 5、支持站点+栏目管理模式,采集管理一目了然; 6、支持链接替换、分页链接替换,破解部分使用JS/backend程序设置的反扒功能; 7、支持采集器设置无限过滤功能; 8、支持图片采集保存到本地,自动替换文件名避免重复; 9、支持FLASH文件采集保存到本地,自动替换文件名,避免重复; 10、支持限制PHP FOPEN和FSOCKET功能的虚拟主机; 11、支持采集手动筛选结果,并提供“空标题空内容”的快速过滤和删除; 12、支持Flash专业站采集,特色采集flash小游戏,完善采集缩略图,游戏介绍; 13、支持全站配置规则的导入导出; 14、support栏目 配置规则导入导出,提供规则复制功能,简化设置; 15、提供引导库规则导入导出; 16、支持自定义采集间隔时间,避免被误认为DDOS攻击而拒绝响应,可以采集设置网站防止DDOS攻击; 17、支持自定义存储间隔时间,避免虚拟主机并发限制; 18、支持自定义内容写入,用户可以设置任意内容(如您自己的链接、广告代码),写入采集内容:第一个、最后一个或随机写入;需要编写的内容在您导库时自动带在您身边,无需修改您的WEB系统模板。

19、支持采集内容替换功能,用户可以设置替换规则随意替换; 20、支持html标签过滤,允许采集只保留必要的html标签甚至不保留html标签的纯文本。如果系统默认标签不能满足您的需求,您还可以自定义其他HTML标签来提高采集性能; 21、支持多个cms导库如:小蜜蜂商业门户网站系统(BBWPS)、Dedecms(织梦)、PHP168、mephpcms、Mambo、Joomla、DuoXun , SupeSite, cmsware, 帝国Ecms, Xinyudongwang (XYDW)cms、动易cms、风讯cms、HUGESKY cms、PHPcms系统指南库; 22、支持PHPWIND、Discuz、BBSxp论坛指南库; 23、支持WordPress、Bo_Blog日志系统指南库,除了官方指南库规则,您还可以设计自己的系统指南库规则。指南库设计功能完全开放; 24、自带数据库优化工具,减少频繁采集数据碎片减少数据库性能。以下特殊功能仅适用于“小蜜蜂采集器”:1、支持采集进程断点续传功能,不受浏览器意外关闭影响,采集后不再重复重新启动; 2、支持自动比较过滤功能,采集的链接系统不会有重复的采集和存储;以上两个功能可以大大减少采集时间,减少系统负载。 3、支持系统每天自动创建图片存储目录,方便管理; 4、支持采集/guide库间隔设置,避免被目标站识别为流量攻击而拒绝响应; 5、支持自定义内容编写6、支持html标签过滤,可以近乎完美的展现你想要的采集效果; 7、Perfect 内容存储解决方案不受目标程序语言和数据库类别的限制。 查看全部

系统默认的标签提升采集性能是什么?-八维教育

功能介绍:1、support文章内容分页采集;2、support forum采集3、support UTF-8转GB2312,采集内容字符格式可以是UTF-8目标; 4、 支持在本地保存文章 内容; 5、支持站点+栏目管理模式,采集管理一目了然; 6、支持链接替换、分页链接替换,破解部分使用JS/backend程序设置的反扒功能; 7、支持采集器设置无限过滤功能; 8、支持图片采集保存到本地,自动替换文件名避免重复; 9、支持FLASH文件采集保存到本地,自动替换文件名,避免重复; 10、支持限制PHP FOPEN和FSOCKET功能的虚拟主机; 11、支持采集手动筛选结果,并提供“空标题空内容”的快速过滤和删除; 12、支持Flash专业站采集,特色采集flash小游戏,完善采集缩略图,游戏介绍; 13、支持全站配置规则的导入导出; 14、support栏目 配置规则导入导出,提供规则复制功能,简化设置; 15、提供引导库规则导入导出; 16、支持自定义采集间隔时间,避免被误认为DDOS攻击而拒绝响应,可以采集设置网站防止DDOS攻击; 17、支持自定义存储间隔时间,避免虚拟主机并发限制; 18、支持自定义内容写入,用户可以设置任意内容(如您自己的链接、广告代码),写入采集内容:第一个、最后一个或随机写入;需要编写的内容在您导库时自动带在您身边,无需修改您的WEB系统模板。

19、支持采集内容替换功能,用户可以设置替换规则随意替换; 20、支持html标签过滤,允许采集只保留必要的html标签甚至不保留html标签的纯文本。如果系统默认标签不能满足您的需求,您还可以自定义其他HTML标签来提高采集性能; 21、支持多个cms导库如:小蜜蜂商业门户网站系统(BBWPS)、Dedecms(织梦)、PHP168、mephpcms、Mambo、Joomla、DuoXun , SupeSite, cmsware, 帝国Ecms, Xinyudongwang (XYDW)cms、动易cms、风讯cms、HUGESKY cms、PHPcms系统指南库; 22、支持PHPWIND、Discuz、BBSxp论坛指南库; 23、支持WordPress、Bo_Blog日志系统指南库,除了官方指南库规则,您还可以设计自己的系统指南库规则。指南库设计功能完全开放; 24、自带数据库优化工具,减少频繁采集数据碎片减少数据库性能。以下特殊功能仅适用于“小蜜蜂采集器”:1、支持采集进程断点续传功能,不受浏览器意外关闭影响,采集后不再重复重新启动; 2、支持自动比较过滤功能,采集的链接系统不会有重复的采集和存储;以上两个功能可以大大减少采集时间,减少系统负载。 3、支持系统每天自动创建图片存储目录,方便管理; 4、支持采集/guide库间隔设置,避免被目标站识别为流量攻击而拒绝响应; 5、支持自定义内容编写6、支持html标签过滤,可以近乎完美的展现你想要的采集效果; 7、Perfect 内容存储解决方案不受目标程序语言和数据库类别的限制。

文章采集完( php中文网的详细内容区域及采集节点详细解析!!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-09-18 09:17

php中文网的详细内容区域及采集节点详细解析!!)

14、Get Title:

15、这是采集的内容区域:

16、获取新闻内容:

(注意:通配符用于新闻内容规则中的d_id='*'。由于每个新闻的d_id值不同,因此可以用*替换,而“*”可以替换任何字符。)

17、点击提交完成整个采集节点:

二、Preview采集节点是否正确

1、点击提交返回管理节点:

2、点击“预览”采集进入节点预览结果:

3、采集内容页列表:

4、采集内容页:

三、采集

1、预览采集节点,然后返回“管理节点”,单击“启动采集”链接启动采集:

2、系统在采集中:

3、采集完成后,将显示本地临时收据信息。此时,您可以修改或删除临时入库信息:

4、修改信息页面,如图所示:

5、查看并存储采集的信息,然后单击“存储中的所有信息”:

6、确认操作:

7、信息入库完成提示:

信息存储后,点击“管理信息”:

我们可以看到采集存储的新闻信息:

最后,刷新“数据更新”中的主页、列和内容页,以完成网站的采集信息@

以上是帝国cms如何采集的详细信息。请关注PHP中文网站上其他相关的文章

声明:本文原创发布PHP中文网站。请注明转载来源。谢谢你的尊重!如果您有任何问题,请与我们联系 查看全部

文章采集完(

php中文网的详细内容区域及采集节点详细解析!!)

14、Get Title:

15、这是采集的内容区域:

16、获取新闻内容:

(注意:通配符用于新闻内容规则中的d_id='*'。由于每个新闻的d_id值不同,因此可以用*替换,而“*”可以替换任何字符。)

17、点击提交完成整个采集节点:

二、Preview采集节点是否正确

1、点击提交返回管理节点:

2、点击“预览”采集进入节点预览结果:

3、采集内容页列表:

4、采集内容页:

三、采集

1、预览采集节点,然后返回“管理节点”,单击“启动采集”链接启动采集:

2、系统在采集中:

3、采集完成后,将显示本地临时收据信息。此时,您可以修改或删除临时入库信息:

4、修改信息页面,如图所示:

5、查看并存储采集的信息,然后单击“存储中的所有信息”:

6、确认操作:

7、信息入库完成提示:

信息存储后,点击“管理信息”:

我们可以看到采集存储的新闻信息:

最后,刷新“数据更新”中的主页、列和内容页,以完成网站的采集信息@

以上是帝国cms如何采集的详细信息。请关注PHP中文网站上其他相关的文章

声明:本文原创发布PHP中文网站。请注明转载来源。谢谢你的尊重!如果您有任何问题,请与我们联系

文章采集完(免费下载或者VIP会员资源能否直接商用?浏览器下载)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2021-09-17 16:19

免费下载或VIP会员资源是否可以直接商业化

本网站所有资源的版权归原作者所有。此处提供的资源仅供参考和学习。请不要直接使用。如因商业使用引起版权纠纷,一切责任由用户承担。有关更多说明,请参阅VIP简介

提示:下载后,但无法解压缩或打开

最常见的情况是下载不完整:您可以将压缩包的容量与网络磁盘上的容量进行比较。如果小于网络磁盘提示的容量,这就是原因。这是一个由浏览器下载的错误。建议下载百度在线硬盘软件或迅雷。如果排除此情况,请在相应资源的底部留言或与我们联系

在材料资源介绍文章中找不到示例图片@

对于会员专属的全站源代码、程序插件、网站模板、网页模板等类型的资料,用于介绍的文章@图片通常不收录在相应的可下载资料包中。这些相关的商业图片需要单独购买,本网站不负责(也没有办法)查找来源。类似地,某些字体文件也是如此,但有些材料在材料包中会有字体下载链接列表

付款后无法显示下载地址或查看内容

如果您已成功付款,但弹出网站无成功提示,请联系网站管理员为您提供付款信息

购买此资源后,我可以获得退款吗

源材料是一种虚拟商品,可以复制和传播。一旦批准,它将不接受任何形式的退款或兑换要求。请在购买前确认这是您所需的资源 查看全部

文章采集完(免费下载或者VIP会员资源能否直接商用?浏览器下载)

免费下载或VIP会员资源是否可以直接商业化

本网站所有资源的版权归原作者所有。此处提供的资源仅供参考和学习。请不要直接使用。如因商业使用引起版权纠纷,一切责任由用户承担。有关更多说明,请参阅VIP简介

提示:下载后,但无法解压缩或打开

最常见的情况是下载不完整:您可以将压缩包的容量与网络磁盘上的容量进行比较。如果小于网络磁盘提示的容量,这就是原因。这是一个由浏览器下载的错误。建议下载百度在线硬盘软件或迅雷。如果排除此情况,请在相应资源的底部留言或与我们联系

在材料资源介绍文章中找不到示例图片@

对于会员专属的全站源代码、程序插件、网站模板、网页模板等类型的资料,用于介绍的文章@图片通常不收录在相应的可下载资料包中。这些相关的商业图片需要单独购买,本网站不负责(也没有办法)查找来源。类似地,某些字体文件也是如此,但有些材料在材料包中会有字体下载链接列表

付款后无法显示下载地址或查看内容

如果您已成功付款,但弹出网站无成功提示,请联系网站管理员为您提供付款信息

购买此资源后,我可以获得退款吗

源材料是一种虚拟商品,可以复制和传播。一旦批准,它将不接受任何形式的退款或兑换要求。请在购买前确认这是您所需的资源

文章采集完(网上找写手写作,一个SEO不会写作就完蛋了)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-09-15 19:06

1、company news,可以将公司最近的事件和通知整理成文章

2、产品使用介绍,产品使用的详细说明或产品使用后的感觉分为文章

3、如果有大量的咨询,你可以把客服和用户之间的对话变成文章

1、寻找一些被屏蔽蜘蛛捕获的网站,然后直接采集他们的网站和文章

2、open网站国外直接采集

3、采集国内商品文章,然后将其更改为伪原创

找一个作家在线写作。如果搜索引擎优化不能写,那就结束了

网站的内容是整个网站的核心,内容质量是搜索引擎判断网站质量的一个重要指标,因此内容来源制约着整个网站的发展,网站的内容短缺是中小企业网站普遍存在的问题。因此,如何获得大量高质量的网站内容成为这些网站建设中站长们最棘手的问题。Metinfo将教您如何获得稳定的高质量网站内容源

1:写你自己的原创文章

原创文章是最流行的搜索引擎。伪原创7文章的目的是让搜索引擎知道我们的网站有高质量的内容。不断更新高质量内容的网站将吸引搜索引擎索引,这也将促进网站内容的更新

此外,这些高质量的原创内容将被许多网站管理员转载或被许多文章采集器捕获,这将始终产生许多优秀的外部链接。但是,自己编写原创的原创文章会消耗时间和精力。你可能会说:那么多原创内容在哪里?一位大师曾经就这个问题发表过自己的看法。以下是他关于围绕一个不受欢迎的产品扩展内容的建议

(1)从产品的历史和演变开始:产品是如何发明的,每次更新都是什么样的过程?发明家和创新者分别是谁。产品做出了哪些具体贡献,获得了哪些奖项?如果产品是由贵公司发明的,那么还有更多的内容要写t

(2)从制造产品的人开始:谁是研发团队、背景、经验以及直接生产产品的工人需要什么技能

(3)从原材料开始:产品是用什么原材料制成的,这些材料在哪里生产得最好,为什么

当然,围绕产品有很多角度可以描述。只要你敞开心扉,任何产品都可以写出很多相关内容

2:"K17"转载内容

“原创”复制的内容也被称为文章编译。如果我们看到一篇文章文章,并且觉得我们不同意它的一些观点,我们可以从原文中提取观点,然后写下我们自己的观点;或者,如果我们觉得文章中的观点还有扩展的空间,我们可以继续按照原文的想法扩展原文最后一位作者。但是,请记住这里的一个原则,那就是重新创建的文本消息内容。尽量拥有比摘录更多的信息内容

3:鼓励用户贡献内容

事实上,有时候网站的访问者也有强烈的写作和交流的欲望,所以我们可以不断完善网站的互动功能,最简单的方法之一就是打开网站的内容评论功能,让用户参与网站的信息内容建设,当然如果网站是内容,就让用户打开一个subm网站的ission接口通过这里他们创建的内容被提交给网站编辑器,所以有很多好的原创内容

4:翻译外文原创文章

国外有很多优秀且有影响力的文章。如果你的英语足够好,你也可以翻译一些在国外有影响力的文章。不同的词写的文章对于搜索引擎来说是不同的。如果你没有足够的能力写原创文章,翻译别人的文章不是一个好办法好方法

5:采集行业信息

有很多权重高、内容好的论坛,这些论坛存储了很多高质量的信息,无论是行业的前沿内容还是行业的最新趋势,这些论坛都有及时有效的内容,所以你可以搜索这些内容并将其排序到文章或作为优秀的原创文章

6:适当的“伪原创”

@原创是最好的方法,毕竟如果你能记住网站的所有内容。如果你不能做到,你也可以尝试适当的伪原创.当我们收到另一篇文章文章时,我们可以如下编辑伪原创

(@K27文章标题修改)

分类方法:可以修改@ 文章标题顺序,但原意不能改变。例如,美国主机与香港主机的优势可以改变为香港主机对美国主机

的缺点。

文本减少/添加、替换方法:在原创标题上添加或减少一些文本,例如:新手用户选择MetInfocms系统的五大优势可以转化为新手用户选择Metinfo建站系统的五大优势

(2)文本修改)

重写第一段:搜索会使爬行器对文章的第一段及其内容进行估值,因此请尝试重写第一段,并随身携带网站关键词。不需要太长。超过100个单词就足够了

插入链接方法:在文本中插入您自己的网站链接。当其他采集our文章相当于为网站us制作一个外部链时

拆分方法:将原来的文章内容平均分成几段,然后更改伪原创的段落顺序@

标注方法:使用关键词为文章添加友好注释,这样不仅可以自然重复关键词并增加关键词密度,还可以让客户了解更多不熟悉的专业术语

合并方法:准备几个主题相似的文章然后合并内容,使文章成为原创文章的精华 查看全部

文章采集完(网上找写手写作,一个SEO不会写作就完蛋了)

1、company news,可以将公司最近的事件和通知整理成文章

2、产品使用介绍,产品使用的详细说明或产品使用后的感觉分为文章

3、如果有大量的咨询,你可以把客服和用户之间的对话变成文章

1、寻找一些被屏蔽蜘蛛捕获的网站,然后直接采集他们的网站和文章

2、open网站国外直接采集

3、采集国内商品文章,然后将其更改为伪原创

找一个作家在线写作。如果搜索引擎优化不能写,那就结束了

网站的内容是整个网站的核心,内容质量是搜索引擎判断网站质量的一个重要指标,因此内容来源制约着整个网站的发展,网站的内容短缺是中小企业网站普遍存在的问题。因此,如何获得大量高质量的网站内容成为这些网站建设中站长们最棘手的问题。Metinfo将教您如何获得稳定的高质量网站内容源

1:写你自己的原创文章

原创文章是最流行的搜索引擎。伪原创7文章的目的是让搜索引擎知道我们的网站有高质量的内容。不断更新高质量内容的网站将吸引搜索引擎索引,这也将促进网站内容的更新

此外,这些高质量的原创内容将被许多网站管理员转载或被许多文章采集器捕获,这将始终产生许多优秀的外部链接。但是,自己编写原创的原创文章会消耗时间和精力。你可能会说:那么多原创内容在哪里?一位大师曾经就这个问题发表过自己的看法。以下是他关于围绕一个不受欢迎的产品扩展内容的建议

(1)从产品的历史和演变开始:产品是如何发明的,每次更新都是什么样的过程?发明家和创新者分别是谁。产品做出了哪些具体贡献,获得了哪些奖项?如果产品是由贵公司发明的,那么还有更多的内容要写t

(2)从制造产品的人开始:谁是研发团队、背景、经验以及直接生产产品的工人需要什么技能

(3)从原材料开始:产品是用什么原材料制成的,这些材料在哪里生产得最好,为什么

当然,围绕产品有很多角度可以描述。只要你敞开心扉,任何产品都可以写出很多相关内容

2:"K17"转载内容

“原创”复制的内容也被称为文章编译。如果我们看到一篇文章文章,并且觉得我们不同意它的一些观点,我们可以从原文中提取观点,然后写下我们自己的观点;或者,如果我们觉得文章中的观点还有扩展的空间,我们可以继续按照原文的想法扩展原文最后一位作者。但是,请记住这里的一个原则,那就是重新创建的文本消息内容。尽量拥有比摘录更多的信息内容

3:鼓励用户贡献内容

事实上,有时候网站的访问者也有强烈的写作和交流的欲望,所以我们可以不断完善网站的互动功能,最简单的方法之一就是打开网站的内容评论功能,让用户参与网站的信息内容建设,当然如果网站是内容,就让用户打开一个subm网站的ission接口通过这里他们创建的内容被提交给网站编辑器,所以有很多好的原创内容

4:翻译外文原创文章

国外有很多优秀且有影响力的文章。如果你的英语足够好,你也可以翻译一些在国外有影响力的文章。不同的词写的文章对于搜索引擎来说是不同的。如果你没有足够的能力写原创文章,翻译别人的文章不是一个好办法好方法

5:采集行业信息

有很多权重高、内容好的论坛,这些论坛存储了很多高质量的信息,无论是行业的前沿内容还是行业的最新趋势,这些论坛都有及时有效的内容,所以你可以搜索这些内容并将其排序到文章或作为优秀的原创文章

6:适当的“伪原创”

@原创是最好的方法,毕竟如果你能记住网站的所有内容。如果你不能做到,你也可以尝试适当的伪原创.当我们收到另一篇文章文章时,我们可以如下编辑伪原创

(@K27文章标题修改)

分类方法:可以修改@ 文章标题顺序,但原意不能改变。例如,美国主机与香港主机的优势可以改变为香港主机对美国主机

的缺点。

文本减少/添加、替换方法:在原创标题上添加或减少一些文本,例如:新手用户选择MetInfocms系统的五大优势可以转化为新手用户选择Metinfo建站系统的五大优势

(2)文本修改)

重写第一段:搜索会使爬行器对文章的第一段及其内容进行估值,因此请尝试重写第一段,并随身携带网站关键词。不需要太长。超过100个单词就足够了

插入链接方法:在文本中插入您自己的网站链接。当其他采集our文章相当于为网站us制作一个外部链时

拆分方法:将原来的文章内容平均分成几段,然后更改伪原创的段落顺序@

标注方法:使用关键词为文章添加友好注释,这样不仅可以自然重复关键词并增加关键词密度,还可以让客户了解更多不熟悉的专业术语

合并方法:准备几个主题相似的文章然后合并内容,使文章成为原创文章的精华

文章采集完(如何通过本地客户端远程访问服务端来进行数据采集,存储和查询.本期)

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-09-13 17:04

上一期我们学习了html页面采集之后的数据查询,但这只是本地查询数据库。如果我们要使用远程操作来存储和查询数据采集,我们应该怎么做? ?今天一起来学习一下:如何使用本地客户端远程访问服务器进行采集、数据的存储和查询。

此问题概述

上一期我们学习了html页面采集之后的数据查询,但这只是本地查询数据库。如果我们要使用远程操作来存储和查询数据采集,我们应该怎么做? ?

今天一起来学习:如何使用本地客户端远程访问服务器进行采集,数据的存储和查询。

Data采集page 2011-2012赛季英超球队战绩

学习简单的远程访问(RMI 示例)

首先,我们来学习一个客户端远程访问服务器的简单例子。

这里使用的是Java RMI(远程方法调用)

Java RMI 是一种机制,它使 Java 虚拟机能够调用另一个 Java 虚拟机上的对象的方法以实现远程访问。

但是,要通过客户端实现这种远程访问,必须绑定一个远程接口对象(意味着客户端可以访问的服务器上的方法都必须收录在这个接口中)。

好的,让我们编写示例代码。

定义远程接口

首先,我们需要编写一个远程接口HelloInterface,它继承了远程对象Remote。

接口HelloInterface中有一个sayHello方法,用于客户端连接后打招呼。

由于sayHello方法继承了远程Remote对象,所以需要抛出RemoteException。

package Remote_Interface;

import java.rmi.Remote;

import java.rmi.RemoteException;

/**

* 接口HelloInterface 继承了 远程接口 Remote 用于客户端Client远程调用

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public interface HelloInterface extends Remote{

public String sayHello(String name) throws RemoteException;

}

实现接口(在服务端实现接口)

接下来我们实现接口中的方法,实现接口的方法在服务器端。

这里的 HelloInterfaceImpl 类实现了接口 HelloInterface 中的方法。

注意:这里的HelloInterfaceImpl也继承了U优采云tRemoteObject远程对象。这个必须写。代码智能提示虽然不写代码不会提示错误,但是在服务器启动后会莫名其妙的报错。

由于U优采云tRemoteObject远程对象需要抛出RemoteException,所以使用构造方法HelloInterfaceImpl()来抛出这个异常。

package Server;

import java.rmi.RemoteException;

import java.rmi.server.UnicastRemoteObject;

import Remote_Interface.HelloInterface;

/**

* HelloInterfaceImpl 用于实现 接口HelloInterface 的远程 SayHello方法

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

@SuppressWarnings("serial")

// 继承 UnicastRemoteObject 远程对象 这个一定要写 否则 服务端启动报异常

public class HelloInterfaceImpl extends UnicastRemoteObject implements HelloInterface{

//HelloInterfaceImpl的构造方法 用于抛出UnicastRemoteObject 远程对象里的异常

protected HelloInterfaceImpl() throws RemoteException {

}

public String sayHello(String name) throws RemoteException {

//该信息 在客户端上发出

String strHello = "你好! " + name+" 欢迎访问服务端!";

//这条信息 是在服务端上 打印出来

System.out.println(name +" 正在 访问本服务端!");

return strHello;

}

}

写服务端

接下来我们来写服务端,因为RMI实现远程访问的机制是指:客户端通过在RMI注册表中查找远程接口对象的地址(服务器地址)来达到远程访问的目的,

所以,我们需要在服务端创建一个远程对象注册中心来绑定和注册服务端地址和远程接口对象,以便后面的客户端可以成功找到服务端(详见代码注释)。

package Server;

import java.net.MalformedURLException;

import java.rmi.AlreadyBoundException;

import java.rmi.Naming;

import java.rmi.RemoteException;

import java.rmi.registry.LocateRegistry;

import Remote_Interface.HelloInterface;

/**

* Server 类 用于 启动 注册服务端

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public class Server {

public static void main(String[] args) {

try {

// 定义远程接口HelloInterface 对象 用于绑定在服务端注册表上 该接口由HelloInterfaceImpl()类实现

HelloInterface hInterface = new HelloInterfaceImpl();

int port = 6666; // 定义一个端口号

// 创建一个接受对特定端口调用的远程对象注册表 注册表上需要接口一个指定的端口号

LocateRegistry.createRegistry(port);

// 定义 服务端远程地址 URL格式

String address = "rmi://localhost:" + port + "/hello";

// 绑定远程地址和接口对象

Naming.bind(address,hInterface);

// 如果启动成功 则弹出如下信息

System.out.println(">>>服务端启动成功");

System.out.println(">>>请启动客户端进行连接访问");

} catch (MalformedURLException e) {

System.out.println("地址出现错误!");

e.printStackTrace();

} catch (AlreadyBoundException e) {

System.out.println("重复绑定了同一个远程对象!");

e.printStackTrace();

} catch (RemoteException e) {

System.out.println("创建远程对象出现错误!");

e.printStackTrace();

}

}

}

写客户端

服务端完成,我们写下访问服务端所需的客户端。

客户端还需要定义一个远程访问地址——即服务器地址,

然后,通过在 RMI 注册表中查找地址;如果找到,则建立连接。

package Client;

import java.net.MalformedURLException;

import java.rmi.Naming;

import java.rmi.NotBoundException;

import java.rmi.RemoteException;

import Remote_Interface.HelloInterface;

/**

* Client 用于连接 并访问 服务端Server

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public class Client {

public static void main(String[] args) {

// 定义一个端口号 该端口号必须与服务端的端口号相同

int port = 6666;

// 同样定义一个远程地址 该地址为服务端的远程地址 所以 与服务端的地址是一样的

String address = "rmi://localhost:" + port + "/hello";

// 在RMI注册表上需找 对象为HelloInterface的地址 即服务端地址

try {

HelloInterface hInterface = (HelloInterface) Naming.lookup(address);

// 一旦客户端找到该服务端地址 则 进行连接

System.out.println(">>服务端启动成功");

System.out.println(">>>请启动客户端进行连接访问");

} catch (MalformedURLException e) {

System.out.println("地址出现错误!");

e.printStackTrace();

} catch (AlreadyBoundException e) {

System.out.println("重复绑定了同一个远程对象!");

e.printStackTrace();

} catch (RemoteException e) {

System.out.println("创建远程对象出现错误!");

e.printStackTrace();

}

}

}

Data采集AndStorage 类和里面的 dataCollectAndStore() 方法用于采集和存储数据。

Data采集AndStorage 类

<p>package Server;

import java.io.BufferedReader;

import java.io.IOException;

import java.io.InputStreamReader;

import java.net.URL;

/**

* DataCollectionAndStorage类 用于数据的收集和存储

* @author SoFlash - 博客园 http://www.cnblogs.com/longwu

*/

public class DataCollectionAndStorage{

/**

* dataCollectAndStore()方法 用于Html数据收集和存储

*/

public void dataCollectAndStore() {

// 首先用一个字符串 来装载网页链接

String strUrl = "http://www.footballresults.org ... 3B%3B

String sqlLeagues = "";

try {

// 创建一个url对象来指向 该网站链接 括号里()装载的是该网站链接的路径

// 更多可以看看 http://wenku.baidu.com/view/81 ... .html

URL url = new URL(strUrl);

// InputStreamReader 是一个输入流读取器 用于将读取的字节转换成字符

// 更多可以看看 http://blog.sina.com.cn/s/blog ... .html

InputStreamReader isr = new InputStreamReader(url.openStream(),

"utf-8"); // 统一使用utf-8 编码模式

// 使用 BufferedReader 来读取 InputStreamReader 转换成的字符

BufferedReader br = new BufferedReader(isr);

String strRead = ""; // new 一个字符串来装载 BufferedReader 读取到的内容

// 定义3个正则 用于获取我们需要的数据

String regularDate = "(\\d{1,2}\\.\\d{1,2}\\.\\d{4})";

String regularTwoTeam = ">[^]*</a>";

String regularResult = ">(\\d{1,2}-\\d{1,2})";

//创建 GroupMethod类的对象 gMethod 方便后期调用其类里的 regularGroup方法

GroupMethod gMethod = new GroupMethod();

//创建DataStructure数据结构 类的对象 用于数据下面的数据存储

DataStructure ds = new DataStructure();

//创建MySql类的对象 用于执行MySql语句

MySql ms = new MySql();