c爬虫抓取网页数据

c爬虫抓取网页数据( 利用PIL包的crop函数得到标签大小将标签剪切保存)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-12-22 23:18

利用PIL包的crop函数得到标签大小将标签剪切保存)

contents_list = driver.find_elements_by_css_selector('dl.board-wrapper dd')

注意这里我们使用的是 find_elements_by_css_selector,并且在元素之后添加了 s。如果不加s,find_element方法只能得到第一个节点。添加s后,可以得到所有满足条件的节点,并以列表形式返回。

获取label的文本内容也很简单,比如提取电影排名:

content['index']= content.find_element_by_css_selector('i.board-index').text

找到标签后,添加 .text 即可获取标签内容。获取标签中的属性值也很简单,比如提取电影名称:contents['title'] = content.find_element_by_css_selector('img.board-img').get_attribute('alt')

找到标签后,添加 .get_attribute('attribute name') 即可获取标签中的属性值。具体例子如下:

for content in contents_list:

contents['index'] = content.find_element_by_css_selector('i.board-index').text

; contents['image_url'] = content.find_element_by_css_selector('img.boardimg').get_attribute('src')

;contents['title'] = content.find_element_by_css_selector('img.boardimg').get_attribute('alt')

try:

contents['actor'] = content.find_element_by_css_selector('p.star').text

; except NoSuchElementException:

;contents['actor'] = ''

; contents['time'] = content.find_element_by_css_selector('p.releasetime').t;

3. 将票房信息保存为图片,使用PIL对图片进行二值化、锐化等预处理操作

保存要获取信息的标签图片的一般步骤如下:

a) 拦截当前窗口(selenium 不能直接拦截单个标签)

b) 获取标签位置坐标和标签大小

c) 使用PIL包的裁剪功能,根据标签的坐标和大小对标签进行裁剪保存

示例如下:

图片

上图是网页截图。使用 save_screenshot 函数获取当前窗口的屏幕截图。我们需要将票房数据裁剪保存在蓝框中,所以需要它们的坐标和大小。幸运的是,我们可以使用 .location 和。size函数获取标签的坐标和大小,最后使用PIL包的crop函数根据标签的坐标和大小对标签进行裁剪和保存。

上述步骤在第一屏捕获信息时非常有用,但是当窗口超过一个屏幕并且需要捕获的元素在后面时,您只能寻找其他方法。

来抓一下猫眼影业的电影票房网页,比较长,不能一屏显示。当然我们也可以用js把网页下拉然后截图,这样也可以截取下面网页的信息,但是获取到的标签位置坐标的参考点在网页的左上角(如上图),并且crop功能在裁剪时使用当前图片的左上角为基准,所以不同基准截取的内容肯定是错误的。

我在网上发现,WebDriver.PhantomJS的内置方法支持整个网页的截图,不是很爽,但是我用的时候就糊涂了。PhantomJS 可以拦截整个网页,但是拦截结果是这样的:

图片

我不能给尼玛什么?同时程序还提示警告selenium不再允许使用PhantomJS。让我们回去默默地使用 chrome。突然,灵光一闪。刚才不能用chrome的原因是location函数和crop函数得到的label坐标在裁剪坐标上是不同的。做吧,这个网页一共有10部电影。我只是下拉 10 次就可以了,所以这里我们有一个 for 循环。window.scrollTo 函数使用下拉网页。它有两个参数。第一个是代表水平方向的参数。要拖动的像素数,第二个代表要垂直拖动的像素数。但是你每次拉下来多少?270px(像素),

咦,你怎么知道?

告诉你一个我们使用微信截图的小技巧,它会显示截图图片的大小。对于这个例子,让我们每次拉下两个电影票房之间的长度。长度为270px,如下图所示。

图片

这样,您应该可以获取每个票房数据标签。得到票房数据标签后,我们需要进行图像预处理(二值化、锐化),最后保存标签。部分代码如下:

length = n*270driver.execute_script('window.scrollTo(0, {}*270)'.format(n))# 保存当前窗口为图片driver.save_screenshot('b.png')# time.sleep(2)# 定位div地址location = div.location# print(location)# 得到div尺寸size = div.size# print(size)left = location['x']top = location['y'] - lengthright = location['x'] + size['width']bottom = location['y'] + size['height'] - length

4. 使用tesseract识别保存的图片,获取票房数据

原票房数据图片:

图片

预处理后的票房数据图片:

图片

使用tesseract对处理后的图片进行识别,部分代码如下:

# 调用tesseract进行文字数字识别,目前对于浅颜色的字体识别率较低,若想提高识别率需要对图片做预处理os.system('echo off')#关闭命令行窗口运行命令的显示os.system('tesseract' + ' ' + filename + ' ' + output + ' ' + '-l num+chi_tra') #默认已配置好系统变量time.sleep(2)f = open(output + ".txt", encoding='utf-8')try: t = f.readlines()[0]

目前没有训练自己的数据识别包,直接使用tesseract已有的数据包,经过多次试验,实时票房识别率达到97%以上。由于总票房字体颜色偏浅,字体偏小,目前识别率还比较低,在60%左右。得到的数据如下图所示:

图片

这是第一次尝试使用图像识别来解决爬虫和到达问题。感觉真的很好玩。目前已经开放了获取标签图像的流程,但在图像预处理和图像识别方面还有很多工作要做。目前使用的是第三方软件Tesseract。-OCR识别,一方面我们会继续研究Tesseract-OCR,另一方面我们也会尝试使用深度学习的方法来提高图像文本的识别准确率。

图片 查看全部

c爬虫抓取网页数据(

利用PIL包的crop函数得到标签大小将标签剪切保存)

contents_list = driver.find_elements_by_css_selector('dl.board-wrapper dd')

注意这里我们使用的是 find_elements_by_css_selector,并且在元素之后添加了 s。如果不加s,find_element方法只能得到第一个节点。添加s后,可以得到所有满足条件的节点,并以列表形式返回。

获取label的文本内容也很简单,比如提取电影排名:

content['index']= content.find_element_by_css_selector('i.board-index').text

找到标签后,添加 .text 即可获取标签内容。获取标签中的属性值也很简单,比如提取电影名称:contents['title'] = content.find_element_by_css_selector('img.board-img').get_attribute('alt')

找到标签后,添加 .get_attribute('attribute name') 即可获取标签中的属性值。具体例子如下:

for content in contents_list:

contents['index'] = content.find_element_by_css_selector('i.board-index').text

; contents['image_url'] = content.find_element_by_css_selector('img.boardimg').get_attribute('src')

;contents['title'] = content.find_element_by_css_selector('img.boardimg').get_attribute('alt')

try:

contents['actor'] = content.find_element_by_css_selector('p.star').text

; except NoSuchElementException:

;contents['actor'] = ''

; contents['time'] = content.find_element_by_css_selector('p.releasetime').t;

3. 将票房信息保存为图片,使用PIL对图片进行二值化、锐化等预处理操作

保存要获取信息的标签图片的一般步骤如下:

a) 拦截当前窗口(selenium 不能直接拦截单个标签)

b) 获取标签位置坐标和标签大小

c) 使用PIL包的裁剪功能,根据标签的坐标和大小对标签进行裁剪保存

示例如下:

图片

上图是网页截图。使用 save_screenshot 函数获取当前窗口的屏幕截图。我们需要将票房数据裁剪保存在蓝框中,所以需要它们的坐标和大小。幸运的是,我们可以使用 .location 和。size函数获取标签的坐标和大小,最后使用PIL包的crop函数根据标签的坐标和大小对标签进行裁剪和保存。

上述步骤在第一屏捕获信息时非常有用,但是当窗口超过一个屏幕并且需要捕获的元素在后面时,您只能寻找其他方法。

来抓一下猫眼影业的电影票房网页,比较长,不能一屏显示。当然我们也可以用js把网页下拉然后截图,这样也可以截取下面网页的信息,但是获取到的标签位置坐标的参考点在网页的左上角(如上图),并且crop功能在裁剪时使用当前图片的左上角为基准,所以不同基准截取的内容肯定是错误的。

我在网上发现,WebDriver.PhantomJS的内置方法支持整个网页的截图,不是很爽,但是我用的时候就糊涂了。PhantomJS 可以拦截整个网页,但是拦截结果是这样的:

图片

我不能给尼玛什么?同时程序还提示警告selenium不再允许使用PhantomJS。让我们回去默默地使用 chrome。突然,灵光一闪。刚才不能用chrome的原因是location函数和crop函数得到的label坐标在裁剪坐标上是不同的。做吧,这个网页一共有10部电影。我只是下拉 10 次就可以了,所以这里我们有一个 for 循环。window.scrollTo 函数使用下拉网页。它有两个参数。第一个是代表水平方向的参数。要拖动的像素数,第二个代表要垂直拖动的像素数。但是你每次拉下来多少?270px(像素),

咦,你怎么知道?

告诉你一个我们使用微信截图的小技巧,它会显示截图图片的大小。对于这个例子,让我们每次拉下两个电影票房之间的长度。长度为270px,如下图所示。

图片

这样,您应该可以获取每个票房数据标签。得到票房数据标签后,我们需要进行图像预处理(二值化、锐化),最后保存标签。部分代码如下:

length = n*270driver.execute_script('window.scrollTo(0, {}*270)'.format(n))# 保存当前窗口为图片driver.save_screenshot('b.png')# time.sleep(2)# 定位div地址location = div.location# print(location)# 得到div尺寸size = div.size# print(size)left = location['x']top = location['y'] - lengthright = location['x'] + size['width']bottom = location['y'] + size['height'] - length

4. 使用tesseract识别保存的图片,获取票房数据

原票房数据图片:

图片

预处理后的票房数据图片:

图片

使用tesseract对处理后的图片进行识别,部分代码如下:

# 调用tesseract进行文字数字识别,目前对于浅颜色的字体识别率较低,若想提高识别率需要对图片做预处理os.system('echo off')#关闭命令行窗口运行命令的显示os.system('tesseract' + ' ' + filename + ' ' + output + ' ' + '-l num+chi_tra') #默认已配置好系统变量time.sleep(2)f = open(output + ".txt", encoding='utf-8')try: t = f.readlines()[0]

目前没有训练自己的数据识别包,直接使用tesseract已有的数据包,经过多次试验,实时票房识别率达到97%以上。由于总票房字体颜色偏浅,字体偏小,目前识别率还比较低,在60%左右。得到的数据如下图所示:

图片

这是第一次尝试使用图像识别来解决爬虫和到达问题。感觉真的很好玩。目前已经开放了获取标签图像的流程,但在图像预处理和图像识别方面还有很多工作要做。目前使用的是第三方软件Tesseract。-OCR识别,一方面我们会继续研究Tesseract-OCR,另一方面我们也会尝试使用深度学习的方法来提高图像文本的识别准确率。

图片

c爬虫抓取网页数据(爬取框架中分两类爬虫 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 47 次浏览 • 2021-12-22 13:20

)

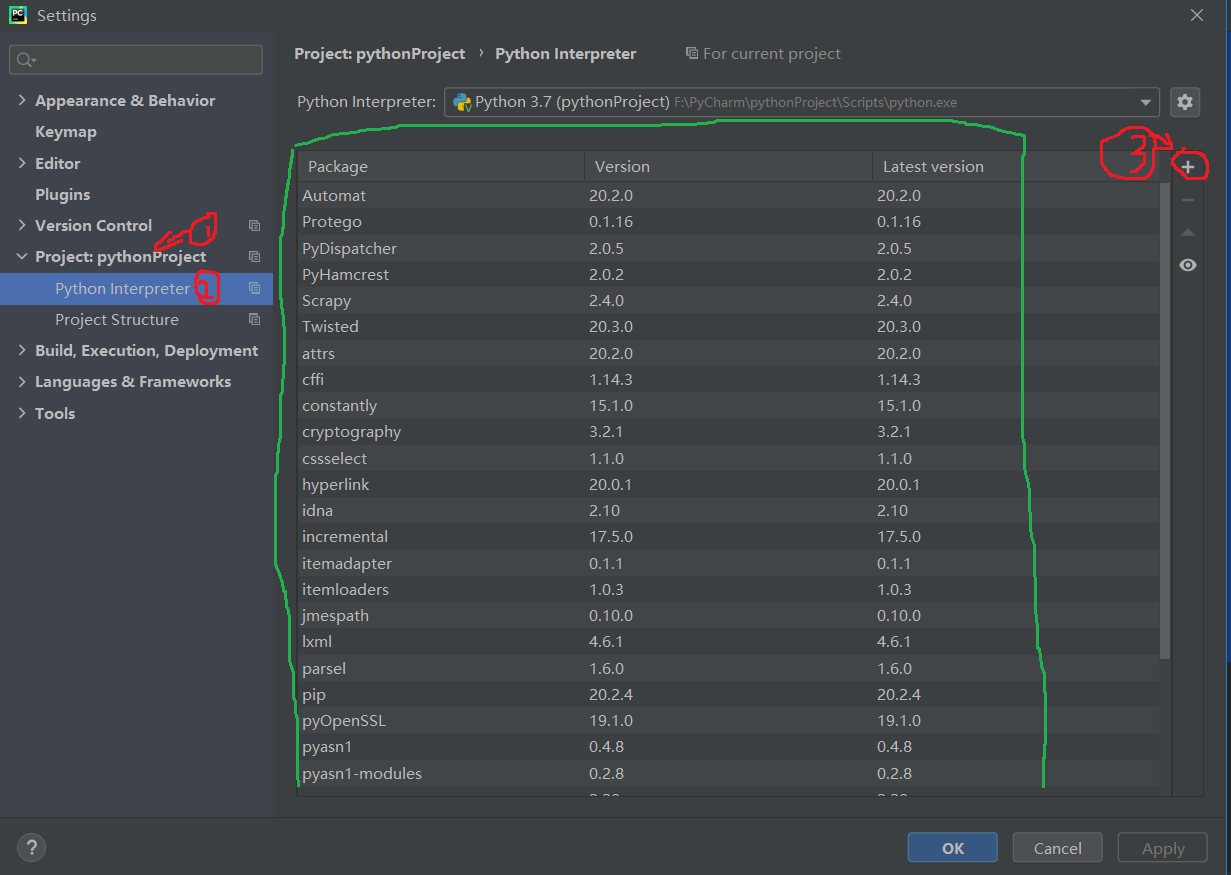

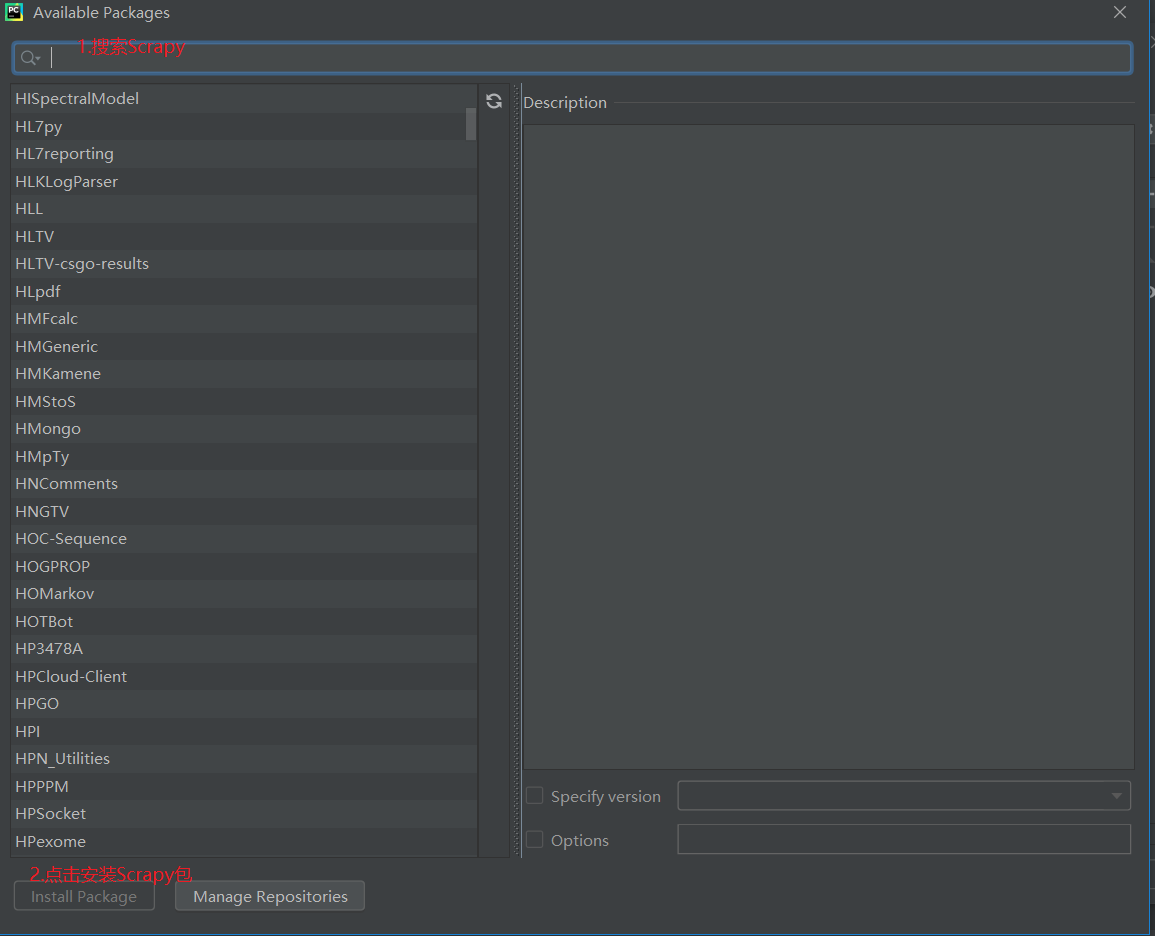

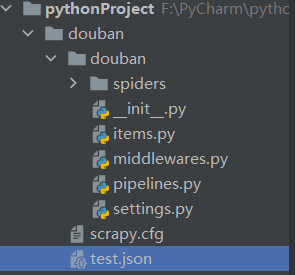

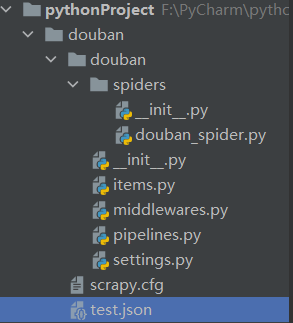

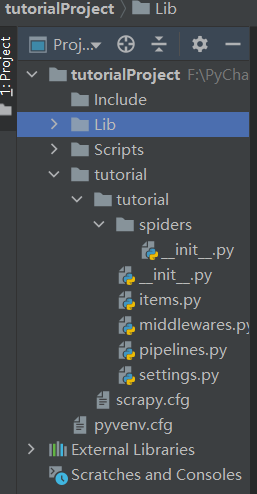

Scrapy 框架中有两种爬虫,Spider 和 CrawlSpider。本案例使用 CrawlSpider 类来实现全站抓取的爬虫。

CrawlSpider 是 Spider 的派生类。Spider类的设计原理是只抓取start_url列表中的网页,而CrawlSpider类则定义了一些规则来提供一种方便的机制来跟踪链接,从抓取到的网页中获取链接并继续抓取。

创建一个 CrawlSpider 模板:

scrapy genspider -t crawl spider名称 www.xxxx.com

LinkExtractors:Link Extractors 的目的是提取链接。Extract_links() 被调用,它提供过滤器以方便提取包括正则表达式在内的链接。过滤器配置有以下构造函数参数:

Rule:规则中收录一个或多个Rule对象,每个Rule定义了爬取网站的具体操作。如果多个规则匹配同一个链接,将根据规则在此集中定义的顺序使用第一个。

下面是一个爬钩网的案例:

蜘蛛.pyi

项目.py

import scrapy

from scrapy.loader.processors import MapCompose, TakeFirst, Join

from scrapy.loader import ItemLoader

from w3lib.html import remove_tags

from LaGouSpider.settings import SQL_DATETIME_FORMAT

class LagouJobItemLoader(ItemLoader):

#自定义Itemloader

default_output_processor = TakeFirst()

def remove_splash(value):

#去掉斜杠

return value.replace("/","")

def handle_jobaddr(value):

addr_list = value.split("\n")

addr_list = [item.strip() for item in addr_list if item.strip()!="查看地图"]

return "".join(addr_list)

class LagouspiderItem(scrapy.Item):

title = scrapy.Field()

url = scrapy.Field()

url_object_id = scrapy.Field()

salary = scrapy.Field()

job_city = scrapy.Field(

input_processor=MapCompose(remove_splash),

)

work_years = scrapy.Field(

input_processor=MapCompose(remove_splash),

)

degree_need = scrapy.Field(

input_processor=MapCompose(remove_splash),

)

job_type = scrapy.Field()

publish_time = scrapy.Field()

job_advantage = scrapy.Field()

job_desc = scrapy.Field()

job_address = scrapy.Field(

input_processor=MapCompose(remove_tags, handle_jobaddr),

)

company_name = scrapy.Field()

company_url = scrapy.Field()

tags = scrapy.Field(

input_processor=Join(",")

)

crawl_time = scrapy.Field()

def get_insert_sql(self):

insert_sql = """

insert into lagou_job(title, url, url_object_id, salary, job_city, work_years, degree_need,

job_type, publish_time, job_advantage, job_desc, job_address, company_name, company_url,

tags, crawl_time) VALUES (%s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s)

ON DUPLICATE KEY UPDATE salary=VALUES(salary), job_desc=VALUES(job_desc)

"""

params = (

self["title"], self["url"], self["url_object_id"], self["salary"], self["job_city"],

self["work_years"], self["degree_need"], self["job_type"],

self["publish_time"], self["job_advantage"], self["job_desc"],

self["job_address"], self["company_name"], self["company_url"],

self["tags"], self["crawl_time"].strftime(SQL_DATETIME_FORMAT),

)

return insert_sql, params

管道.py

from twisted.enterprise import adbapi

import MySQLdb

import MySQLdb.cursors

class LagouspiderPipeline(object):

def process_item(self, item, spider):

return item

class MysqlTwistedPipeline(object):

def __init__(self, dbpool):

self.dbpool = dbpool

@classmethod

def from_settings(clsc,setting):

dbparms = dict(

host =setting["MYSQL_HOST"],

db = setting["MYSQL_DBNAME"],

user = setting["MYSQL_USER"],

password = setting["MYSQL_PASSWORD"],

charset = 'utf8',

cursorclass = MySQLdb.cursors.DictCursor,

use_unicode = True,

)

dbpool = adbapi.ConnectionPool("MySQLdb",**dbparms)

return clsc(dbpool)

def process_item(self, item, spider):

#使用twisted将mysql插入变成异步执行

query = self.dbpool.runInteraction(self.do_insert,item)

query.addErrback(self.handle_error,item,spider) #处理异常

def handle_error(self,failure,item,spider):

#处理异步插入的异常

print(failure)

def do_insert(self,cursor,item):

#执行具体的插入

# 根据不同的item 构建不同的sql语句并插入到mysql中

insert_sql,params = item.get_insert_sql()

cursor.execute(insert_sql, params) 查看全部

c爬虫抓取网页数据(爬取框架中分两类爬虫

)

Scrapy 框架中有两种爬虫,Spider 和 CrawlSpider。本案例使用 CrawlSpider 类来实现全站抓取的爬虫。

CrawlSpider 是 Spider 的派生类。Spider类的设计原理是只抓取start_url列表中的网页,而CrawlSpider类则定义了一些规则来提供一种方便的机制来跟踪链接,从抓取到的网页中获取链接并继续抓取。

创建一个 CrawlSpider 模板:

scrapy genspider -t crawl spider名称 www.xxxx.com

LinkExtractors:Link Extractors 的目的是提取链接。Extract_links() 被调用,它提供过滤器以方便提取包括正则表达式在内的链接。过滤器配置有以下构造函数参数:

Rule:规则中收录一个或多个Rule对象,每个Rule定义了爬取网站的具体操作。如果多个规则匹配同一个链接,将根据规则在此集中定义的顺序使用第一个。

下面是一个爬钩网的案例:

蜘蛛.pyi

项目.py

import scrapy

from scrapy.loader.processors import MapCompose, TakeFirst, Join

from scrapy.loader import ItemLoader

from w3lib.html import remove_tags

from LaGouSpider.settings import SQL_DATETIME_FORMAT

class LagouJobItemLoader(ItemLoader):

#自定义Itemloader

default_output_processor = TakeFirst()

def remove_splash(value):

#去掉斜杠

return value.replace("/","")

def handle_jobaddr(value):

addr_list = value.split("\n")

addr_list = [item.strip() for item in addr_list if item.strip()!="查看地图"]

return "".join(addr_list)

class LagouspiderItem(scrapy.Item):

title = scrapy.Field()

url = scrapy.Field()

url_object_id = scrapy.Field()

salary = scrapy.Field()

job_city = scrapy.Field(

input_processor=MapCompose(remove_splash),

)

work_years = scrapy.Field(

input_processor=MapCompose(remove_splash),

)

degree_need = scrapy.Field(

input_processor=MapCompose(remove_splash),

)

job_type = scrapy.Field()

publish_time = scrapy.Field()

job_advantage = scrapy.Field()

job_desc = scrapy.Field()

job_address = scrapy.Field(

input_processor=MapCompose(remove_tags, handle_jobaddr),

)

company_name = scrapy.Field()

company_url = scrapy.Field()

tags = scrapy.Field(

input_processor=Join(",")

)

crawl_time = scrapy.Field()

def get_insert_sql(self):

insert_sql = """

insert into lagou_job(title, url, url_object_id, salary, job_city, work_years, degree_need,

job_type, publish_time, job_advantage, job_desc, job_address, company_name, company_url,

tags, crawl_time) VALUES (%s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s)

ON DUPLICATE KEY UPDATE salary=VALUES(salary), job_desc=VALUES(job_desc)

"""

params = (

self["title"], self["url"], self["url_object_id"], self["salary"], self["job_city"],

self["work_years"], self["degree_need"], self["job_type"],

self["publish_time"], self["job_advantage"], self["job_desc"],

self["job_address"], self["company_name"], self["company_url"],

self["tags"], self["crawl_time"].strftime(SQL_DATETIME_FORMAT),

)

return insert_sql, params

管道.py

from twisted.enterprise import adbapi

import MySQLdb

import MySQLdb.cursors

class LagouspiderPipeline(object):

def process_item(self, item, spider):

return item

class MysqlTwistedPipeline(object):

def __init__(self, dbpool):

self.dbpool = dbpool

@classmethod

def from_settings(clsc,setting):

dbparms = dict(

host =setting["MYSQL_HOST"],

db = setting["MYSQL_DBNAME"],

user = setting["MYSQL_USER"],

password = setting["MYSQL_PASSWORD"],

charset = 'utf8',

cursorclass = MySQLdb.cursors.DictCursor,

use_unicode = True,

)

dbpool = adbapi.ConnectionPool("MySQLdb",**dbparms)

return clsc(dbpool)

def process_item(self, item, spider):

#使用twisted将mysql插入变成异步执行

query = self.dbpool.runInteraction(self.do_insert,item)

query.addErrback(self.handle_error,item,spider) #处理异常

def handle_error(self,failure,item,spider):

#处理异步插入的异常

print(failure)

def do_insert(self,cursor,item):

#执行具体的插入

# 根据不同的item 构建不同的sql语句并插入到mysql中

insert_sql,params = item.get_insert_sql()

cursor.execute(insert_sql, params)

c爬虫抓取网页数据(如何自学Python爬虫?新手入门到精通的爬虫技能!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2021-12-21 12:28

如何自学 Python 爬虫?在大家学会自己爬之前,有两个常见的问题需要解决。首先,什么是爬虫?二是问为什么要用Python做爬虫?爬虫其实就是一个自动抓取页面信息的网络机器人。至于使用Python作为爬虫的原因,当然是为了方便。本文将为您提供详细的初学者入门教程,带您从入门到精通Python爬虫技巧。

一、什么是爬虫?

网络爬虫也被称为网络蜘蛛、网络机器人,在 FOAF 社区中,它们更多地被称为网络追逐者。它是按照一定的规则自动抓取万维网上信息的程序或脚本。其他不常用的名称包括蚂蚁、自动索引和模拟程序。其实说白了就是爬虫可以模拟浏览器的行为为所欲为,自定义搜索下载的内容,实现自动化操作。比如浏览器可以下载小说,但是有时候不能批量下载,所以爬虫功能很有用。

二、为什么python适合爬行?

实现爬虫技术的编程环境有很多,Java、Python、C++等都可以用于爬虫。但是为什么大家都选择Python呢?因为Python真的很适合爬虫。丰富的第三方库非常强大。几行代码就可以实现你想要的功能;它是跨平台的,对 Linux 和 windows 有很好的支持。. 更重要的是,Python 还擅长数据挖掘和分析。使用Python进行数据爬取和分析的一站式服务,真的很方便。最后,如果你的时间不是很紧,又想快速提高python,最重要的是不怕吃苦,建议你可以群:[832357663],真的很好,很多人都在飞速进步,需要你不怕吃苦!

三、自学Python爬虫的步骤是什么?

1、先学习Python语法基础知识

2、学习Python爬虫常用的几个重要的内置库,urllib,http等,用于下载网页

3、学习正则表达式re、BeautifulSoup(bs4)、Xpath(lxml)等网页解析工具

4、开始一些简单的网站爬取(博主从百度开始的,哈哈),了解爬取数据的过程

5、了解爬虫的一些反爬虫机制,header,robot,时间间隔,代理ip,隐藏域等。

6、学习一些特殊的网站爬虫,解决登录、cookie、动态网页等问题

7、了解爬虫与数据库的结合,以及如何存储爬取的数据

8、学习应用Python的多线程多进程爬取提高爬虫效率

9、学习爬虫框架,Scrapy,PySpider等。

10、学习分布式爬虫(海量数据需求)

四、自学Python爬虫免费教程推荐

《3天掌握Python爬虫》课程主要包括爬虫基础知识和软件准备,HTTP和HTTPS的学习和请求模块的使用,重试模块的使用和处理cookie相关请求,数据提取方法值json,数据提取值 xpath 使用lxml模块学习,xpath和lxml模块练习等。完成本课程后,大家将能够了解爬虫的原理,学会使用python进行网络请求,掌握爬取网页的方法数据。

以上是Python爬虫初学者教程的介绍。其实,如果你有一定的Python编程基础,自学Python爬虫并不难。行动不如心。无论是视频还是其他学习资源,都可以在网上轻松获取。

如何领取python福利教程:

1、喜欢+评论(勾选“同时转发”)

2、关注小编。并回复私信关键词[19]

(一定要发私信哦~点我头像看私信按钮) 查看全部

c爬虫抓取网页数据(如何自学Python爬虫?新手入门到精通的爬虫技能!)

如何自学 Python 爬虫?在大家学会自己爬之前,有两个常见的问题需要解决。首先,什么是爬虫?二是问为什么要用Python做爬虫?爬虫其实就是一个自动抓取页面信息的网络机器人。至于使用Python作为爬虫的原因,当然是为了方便。本文将为您提供详细的初学者入门教程,带您从入门到精通Python爬虫技巧。

一、什么是爬虫?

网络爬虫也被称为网络蜘蛛、网络机器人,在 FOAF 社区中,它们更多地被称为网络追逐者。它是按照一定的规则自动抓取万维网上信息的程序或脚本。其他不常用的名称包括蚂蚁、自动索引和模拟程序。其实说白了就是爬虫可以模拟浏览器的行为为所欲为,自定义搜索下载的内容,实现自动化操作。比如浏览器可以下载小说,但是有时候不能批量下载,所以爬虫功能很有用。

二、为什么python适合爬行?

实现爬虫技术的编程环境有很多,Java、Python、C++等都可以用于爬虫。但是为什么大家都选择Python呢?因为Python真的很适合爬虫。丰富的第三方库非常强大。几行代码就可以实现你想要的功能;它是跨平台的,对 Linux 和 windows 有很好的支持。. 更重要的是,Python 还擅长数据挖掘和分析。使用Python进行数据爬取和分析的一站式服务,真的很方便。最后,如果你的时间不是很紧,又想快速提高python,最重要的是不怕吃苦,建议你可以群:[832357663],真的很好,很多人都在飞速进步,需要你不怕吃苦!

三、自学Python爬虫的步骤是什么?

1、先学习Python语法基础知识

2、学习Python爬虫常用的几个重要的内置库,urllib,http等,用于下载网页

3、学习正则表达式re、BeautifulSoup(bs4)、Xpath(lxml)等网页解析工具

4、开始一些简单的网站爬取(博主从百度开始的,哈哈),了解爬取数据的过程

5、了解爬虫的一些反爬虫机制,header,robot,时间间隔,代理ip,隐藏域等。

6、学习一些特殊的网站爬虫,解决登录、cookie、动态网页等问题

7、了解爬虫与数据库的结合,以及如何存储爬取的数据

8、学习应用Python的多线程多进程爬取提高爬虫效率

9、学习爬虫框架,Scrapy,PySpider等。

10、学习分布式爬虫(海量数据需求)

四、自学Python爬虫免费教程推荐

《3天掌握Python爬虫》课程主要包括爬虫基础知识和软件准备,HTTP和HTTPS的学习和请求模块的使用,重试模块的使用和处理cookie相关请求,数据提取方法值json,数据提取值 xpath 使用lxml模块学习,xpath和lxml模块练习等。完成本课程后,大家将能够了解爬虫的原理,学会使用python进行网络请求,掌握爬取网页的方法数据。

以上是Python爬虫初学者教程的介绍。其实,如果你有一定的Python编程基础,自学Python爬虫并不难。行动不如心。无论是视频还是其他学习资源,都可以在网上轻松获取。

如何领取python福利教程:

1、喜欢+评论(勾选“同时转发”)

2、关注小编。并回复私信关键词[19]

(一定要发私信哦~点我头像看私信按钮)

c爬虫抓取网页数据(一个通用的网络爬虫的基本结构及工作流程(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2021-12-21 11:06

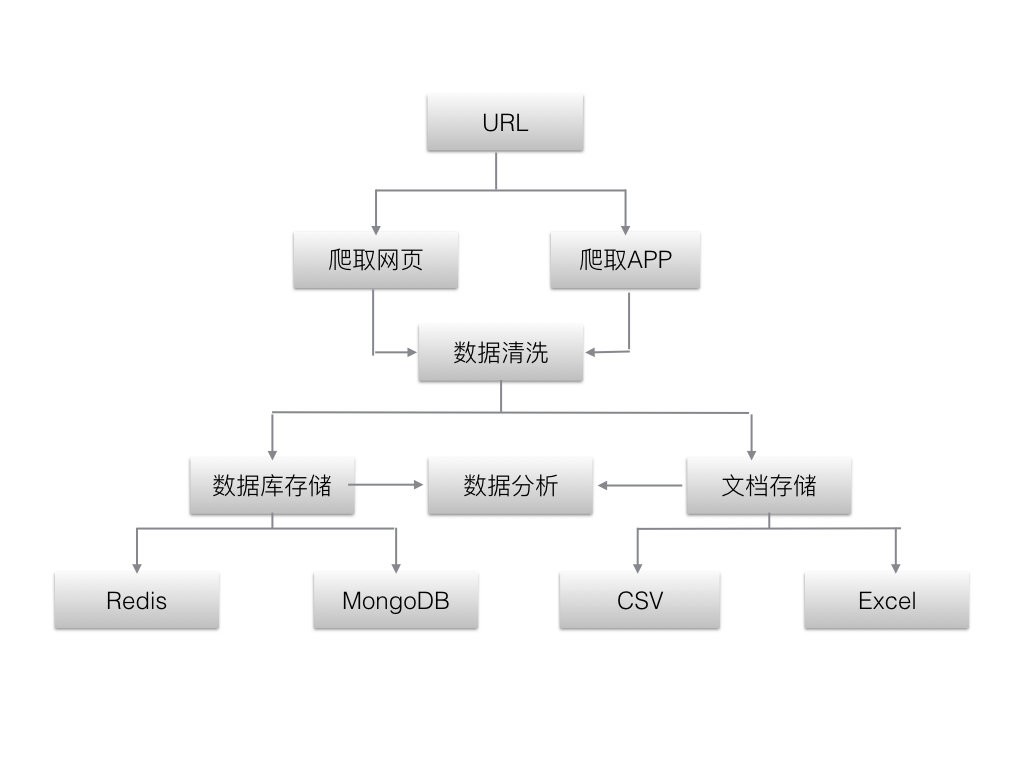

网络爬虫是搜索引擎爬虫系统的重要组成部分。爬虫的主要目的是将互联网上的网页下载到本地,形成网络内容的镜像备份。本篇博客主要是对爬虫和爬虫系统的简要介绍。

一、网络爬虫的基本结构和工作流程

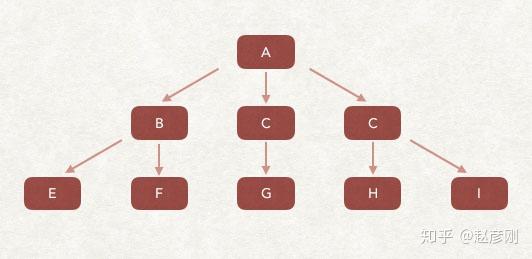

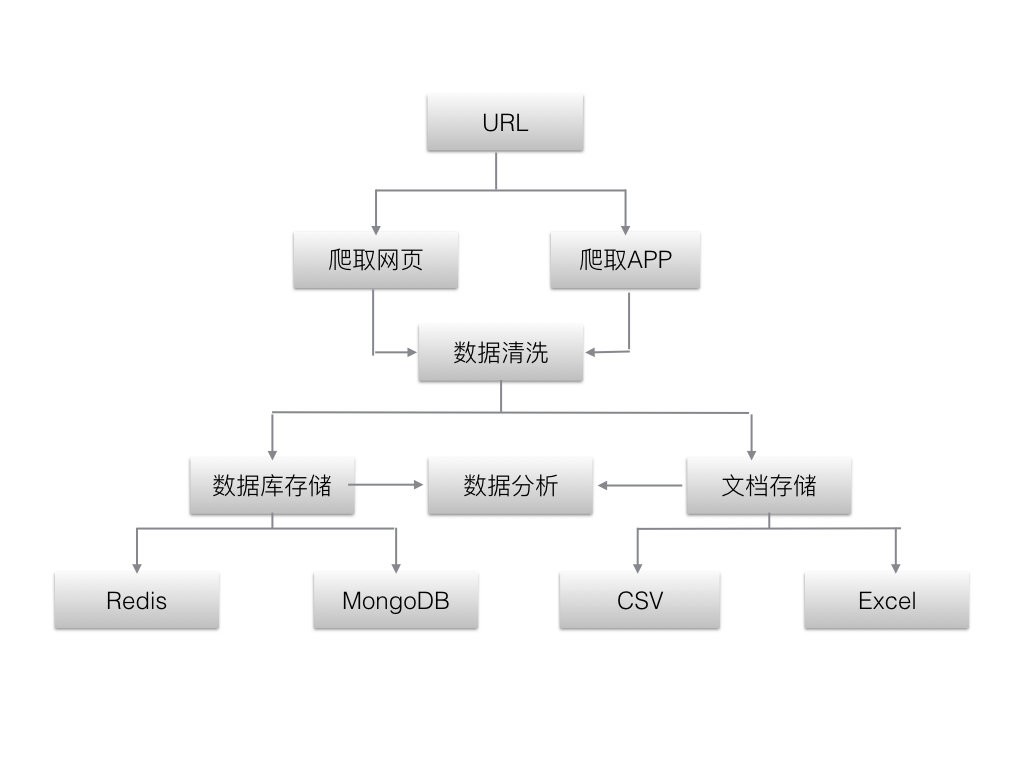

一个通用的网络爬虫的框架如图所示:

网络爬虫的基本工作流程如下:

1.首先选择一些精心挑选的种子网址;

2.将这些URL放入URL队列进行抓取;

3. 从待爬取的URL队列中取出待爬取的URL,解析DNS,获取主机ip,下载该URL对应的网页,并保存到下载的网页库中。另外,将这些网址放入已爬取的网址队列中。

4.对爬取的URL队列中的URL进行分析,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

二、从爬虫的角度划分互联网

相应地,互联网的所有页面可以分为五个部分:

1.下载了未过期的网页

2.已下载并过期的网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态变化的,互联网上的一些内容已经发生了变化。此时,这部分爬取到的页面已经过期。

3.要下载的页面:URL队列中要爬取的那些页面

4. 已知网页:尚未被抓取,也不在待抓取的URL队列中,但通过分析抓取的页面得到的URL或待抓取的URL对应的页面可以认为是已知的网页 。

5.还有一些网页是爬虫无法直接抓取下载的。它被称为不可知页面。

三、抓取策略

在爬虫系统中,要爬取的URL队列是一个非常重要的部分。URL队列中要爬取的URL按什么顺序排列也是一个很重要的问题,因为它涉及到先爬哪个页面,后爬哪个页面。确定这些 URL 顺序的方法称为抓取策略。下面重点介绍几种常见的爬取策略:

1.深度优先遍历策略

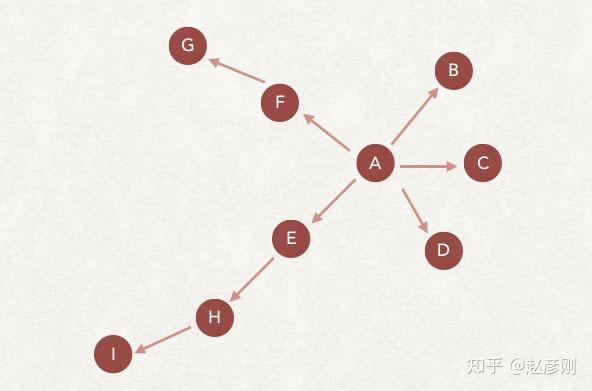

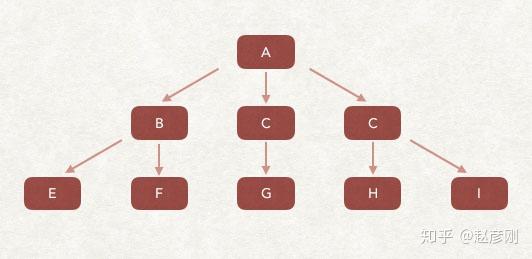

深度优先遍历策略是指网络爬虫会从起始页开始,逐个跟踪每一个链接,处理完这一行后转移到下一个起始页,继续跟踪链接。我们以下图为例:

遍历的路径:AFG EHI BCD

2.宽度优先遍历策略

广度优先遍历策略的基本思想是将新下载的网页中找到的链接直接插入到待爬取的URL队列的末尾。即网络爬虫会先抓取起始网页中所有链接的网页,然后选择其中一个链接的网页,继续抓取该网页中链接的所有网页。以上图为例:

遍历路径:ABCDEF GHI

3.反向链接计数策略

反向链接数是指从其他网页链接到某个网页的数量。反向链接的数量表示网页内容被他人推荐的程度。因此,很多时候搜索引擎的爬取系统都会使用这个指标来评估网页的重要性,从而决定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量不能完全坐等别人的重视。因此,搜索引擎通常会考虑一些可靠的反向链接。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,连同要爬取的URL队列中的URL,组成一个网页集,计算每个页面的PageRank值,经过计算完成后,将要爬取的URL队列中的URL按照PageRank值的大小进行排列,依次爬取页面。

如果每个页面都被抓取,则重新计算 PageRank 值。一个折衷的方案是:每爬取K个页面后,重新计算PageRank值。但是,这种情况下仍然存在一个问题:对于已经从下载页面中分析出来的链接,也就是我们前面提到的未知网页部分,暂时没有PageRank值。为了解决这个问题,这些页面会被赋予一个临时的PageRank值:将所有传入该页面链中的PageRank值聚合起来,从而形成未知页面的PageRank值,从而参与排名。以下示例说明:

5.OPIC 策略

该算法实际上对页面的重要性进行评分。在算法开始之前,给所有页面相同的初始现金(cash)。下载某个页面P后,将P的现金分配给所有从P解析的链接,清空P的现金。待抓取的 URL 队列中的所有页面均按照现金的数量进行排序。

6.大站优先策略

URL队列中所有要爬取的网页,按照所属的网站进行分类。网站需要下载的页面较多,优先下载。这种策略因此被称为大站优先策略。

参考书目:

1. 《这是搜索引擎-核心技术详解》张俊林电子工业出版社

2. 《搜索引擎技术基础》刘义群等清华大学出版社 查看全部

c爬虫抓取网页数据(一个通用的网络爬虫的基本结构及工作流程(组图))

网络爬虫是搜索引擎爬虫系统的重要组成部分。爬虫的主要目的是将互联网上的网页下载到本地,形成网络内容的镜像备份。本篇博客主要是对爬虫和爬虫系统的简要介绍。

一、网络爬虫的基本结构和工作流程

一个通用的网络爬虫的框架如图所示:

网络爬虫的基本工作流程如下:

1.首先选择一些精心挑选的种子网址;

2.将这些URL放入URL队列进行抓取;

3. 从待爬取的URL队列中取出待爬取的URL,解析DNS,获取主机ip,下载该URL对应的网页,并保存到下载的网页库中。另外,将这些网址放入已爬取的网址队列中。

4.对爬取的URL队列中的URL进行分析,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

二、从爬虫的角度划分互联网

相应地,互联网的所有页面可以分为五个部分:

1.下载了未过期的网页

2.已下载并过期的网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态变化的,互联网上的一些内容已经发生了变化。此时,这部分爬取到的页面已经过期。

3.要下载的页面:URL队列中要爬取的那些页面

4. 已知网页:尚未被抓取,也不在待抓取的URL队列中,但通过分析抓取的页面得到的URL或待抓取的URL对应的页面可以认为是已知的网页 。

5.还有一些网页是爬虫无法直接抓取下载的。它被称为不可知页面。

三、抓取策略

在爬虫系统中,要爬取的URL队列是一个非常重要的部分。URL队列中要爬取的URL按什么顺序排列也是一个很重要的问题,因为它涉及到先爬哪个页面,后爬哪个页面。确定这些 URL 顺序的方法称为抓取策略。下面重点介绍几种常见的爬取策略:

1.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,逐个跟踪每一个链接,处理完这一行后转移到下一个起始页,继续跟踪链接。我们以下图为例:

遍历的路径:AFG EHI BCD

2.宽度优先遍历策略

广度优先遍历策略的基本思想是将新下载的网页中找到的链接直接插入到待爬取的URL队列的末尾。即网络爬虫会先抓取起始网页中所有链接的网页,然后选择其中一个链接的网页,继续抓取该网页中链接的所有网页。以上图为例:

遍历路径:ABCDEF GHI

3.反向链接计数策略

反向链接数是指从其他网页链接到某个网页的数量。反向链接的数量表示网页内容被他人推荐的程度。因此,很多时候搜索引擎的爬取系统都会使用这个指标来评估网页的重要性,从而决定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量不能完全坐等别人的重视。因此,搜索引擎通常会考虑一些可靠的反向链接。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,连同要爬取的URL队列中的URL,组成一个网页集,计算每个页面的PageRank值,经过计算完成后,将要爬取的URL队列中的URL按照PageRank值的大小进行排列,依次爬取页面。

如果每个页面都被抓取,则重新计算 PageRank 值。一个折衷的方案是:每爬取K个页面后,重新计算PageRank值。但是,这种情况下仍然存在一个问题:对于已经从下载页面中分析出来的链接,也就是我们前面提到的未知网页部分,暂时没有PageRank值。为了解决这个问题,这些页面会被赋予一个临时的PageRank值:将所有传入该页面链中的PageRank值聚合起来,从而形成未知页面的PageRank值,从而参与排名。以下示例说明:

5.OPIC 策略

该算法实际上对页面的重要性进行评分。在算法开始之前,给所有页面相同的初始现金(cash)。下载某个页面P后,将P的现金分配给所有从P解析的链接,清空P的现金。待抓取的 URL 队列中的所有页面均按照现金的数量进行排序。

6.大站优先策略

URL队列中所有要爬取的网页,按照所属的网站进行分类。网站需要下载的页面较多,优先下载。这种策略因此被称为大站优先策略。

参考书目:

1. 《这是搜索引擎-核心技术详解》张俊林电子工业出版社

2. 《搜索引擎技术基础》刘义群等清华大学出版社

c爬虫抓取网页数据(如何抓取ajax形式加载的网页数据(一)_恢复内容开始)

网站优化 • 优采云 发表了文章 • 0 个评论 • 43 次浏览 • 2021-12-20 06:03

---恢复内容开始---

下面记录如何抓取ajax形式加载的网页数据:

目标:获取"%E5%89%A7%E6%83%85&type=11&interval_id=100:90&action="下的网页数据

第一步:网页数据分析-----》特点:当列表栏滚动到页面底部时,数据自动加载,页面的url没有变化

第二步:使用Fiddler抓包,如下图:

图 1:请求数据

图2:表格形式

数据规律是通过抓包得到的:图2中from形式的start对应数据和图1中url中的start对应数据随着每次加载增加,其他数据没有变化。对应这个规律,我们可以构造相应的请求来获取数据

注意数据格式为json

代码显示如下:

1).urllib 格式

import urllib2

import urllib

#此处的url为上述抓包获取的url去掉start以及limit,start以及limit数据后边以form表单的形式传入

url = \' https://movie.douban.com/j/cha ... on%3D\'

#请求投信息,伪造成浏览器,方式被反爬虫策略拦截

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:60.0) Gecko/20100101 Firefox/60.0"}

#构建form表单

formdata = {

"start":"20",

"limit":"20"

}

#urlencode()urllib中的函数,作用:将key:value形式的键值对转换为"key=value"形式的字符串

data = urllib.urlencode(formdata)

#构建request实例对象

request = urllib2.Request(url,data=data,headers=headers)

#发送请求并返回响应信息

response = urllib2.urlopen(request)

#注意此处的数据形式并不是html文档,而是json数据

json = response.read()

print html

2).request 库获取请求代码

#coding=utf-8

import requests

url = \' https://movie.douban.com/j/cha ... on%3D\'

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:60.0) Gecko/20100101 Firefox/60.0"}

data = {

"start":"20",

"limit":"20",

}

response = requests.get(url,params = data,headers = headers)

print response.text

3).request 库发布请求

#coding=utf-8

import requests

url = \' https://movie.douban.com/j/cha ... on%3D\'

formdata = {

"start":"20",

"limit":"20"

}

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:60.0) Gecko/20100101 Firefox/60.0"}

response = requests.post(url,data=formdata,headers=headers)

print response.text

---恢复内容结束--- 查看全部

c爬虫抓取网页数据(如何抓取ajax形式加载的网页数据(一)_恢复内容开始)

---恢复内容开始---

下面记录如何抓取ajax形式加载的网页数据:

目标:获取"%E5%89%A7%E6%83%85&type=11&interval_id=100:90&action="下的网页数据

第一步:网页数据分析-----》特点:当列表栏滚动到页面底部时,数据自动加载,页面的url没有变化

第二步:使用Fiddler抓包,如下图:

图 1:请求数据

图2:表格形式

数据规律是通过抓包得到的:图2中from形式的start对应数据和图1中url中的start对应数据随着每次加载增加,其他数据没有变化。对应这个规律,我们可以构造相应的请求来获取数据

注意数据格式为json

代码显示如下:

1).urllib 格式

import urllib2

import urllib

#此处的url为上述抓包获取的url去掉start以及limit,start以及limit数据后边以form表单的形式传入

url = \' https://movie.douban.com/j/cha ... on%3D\'

#请求投信息,伪造成浏览器,方式被反爬虫策略拦截

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:60.0) Gecko/20100101 Firefox/60.0"}

#构建form表单

formdata = {

"start":"20",

"limit":"20"

}

#urlencode()urllib中的函数,作用:将key:value形式的键值对转换为"key=value"形式的字符串

data = urllib.urlencode(formdata)

#构建request实例对象

request = urllib2.Request(url,data=data,headers=headers)

#发送请求并返回响应信息

response = urllib2.urlopen(request)

#注意此处的数据形式并不是html文档,而是json数据

json = response.read()

print html

2).request 库获取请求代码

#coding=utf-8

import requests

url = \' https://movie.douban.com/j/cha ... on%3D\'

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:60.0) Gecko/20100101 Firefox/60.0"}

data = {

"start":"20",

"limit":"20",

}

response = requests.get(url,params = data,headers = headers)

print response.text

3).request 库发布请求

#coding=utf-8

import requests

url = \' https://movie.douban.com/j/cha ... on%3D\'

formdata = {

"start":"20",

"limit":"20"

}

headers = {"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:60.0) Gecko/20100101 Firefox/60.0"}

response = requests.post(url,data=formdata,headers=headers)

print response.text

---恢复内容结束---

c爬虫抓取网页数据(1.网络爬虫的基本概念网络蜘蛛,机器人都能够做到! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2021-12-20 06:03

)

1.网络爬虫的基本概念

网络爬虫(又称网络蜘蛛、机器人)是一种模拟客户端发送网络请求和接收请求响应的程序。它是一种按照一定的规则自动抓取互联网信息的程序。

只要浏览器能做,原则上爬虫都能做。

2.网络爬虫的功能

网络爬虫可以做很多事情而不是手动。比如可以作为搜索引擎,还可以爬取网站上面的图片。比如有的朋友爬取一些网站上的所有图片,然后重点关注。同时,网络爬虫还可以应用在金融投资领域,比如可以自动爬取一些金融信息,进行投资分析。

有时候,可能会有几个我们比较喜欢的新闻网站,每次都要打开这些新闻网站浏览,比较麻烦。这时候就可以用网络爬虫把这多条新闻网站中的新闻信息爬下来,一起阅读。

有时,我们在浏览网页信息时,会发现有很多广告。这时候也可以使用爬虫爬取对应网页上的信息,让这些广告自动过滤掉,方便信息的阅读和使用。

有时,我们需要进行营销,因此如何找到目标客户和目标客户的联系方式是一个关键问题。我们可以在网上手动搜索,但是效率会很低。这时,我们可以使用爬虫设置相应的规则,自动从互联网上采集目标用户的联系方式等数据,用于我们的营销。

有时,我们要分析某个网站的用户信息,比如分析网站的用户活跃度、评论数、热门文章等信息。如果我们不是网站管理员,手工统计将是一个非常庞大的工程。此时就可以使用爬虫轻松获取这些数据采集进行进一步分析,而且所有的爬取操作都是自动进行的,我们只需要编写相应的爬虫,设计相应的规则就可以了。

此外,爬虫还可以实现很多强大的功能。总之,爬虫的出现在一定程度上可以替代人工访问网页。因此,我们需要手动访问互联网信息的操作现在可以通过爬虫自动化,从而可以更有效地使用互联网中的有效信息。.

3.安装第三方库

在抓取和解析数据之前,您需要在 Python 运行环境中下载并安装第三方库请求。

在Windows系统中,打开cmd(命令提示符)界面,在界面上输入pip install requests,按回车键安装。(注意网络连接)如下图

安装完成,如图

查看全部

c爬虫抓取网页数据(1.网络爬虫的基本概念网络蜘蛛,机器人都能够做到!

)

1.网络爬虫的基本概念

网络爬虫(又称网络蜘蛛、机器人)是一种模拟客户端发送网络请求和接收请求响应的程序。它是一种按照一定的规则自动抓取互联网信息的程序。

只要浏览器能做,原则上爬虫都能做。

2.网络爬虫的功能

网络爬虫可以做很多事情而不是手动。比如可以作为搜索引擎,还可以爬取网站上面的图片。比如有的朋友爬取一些网站上的所有图片,然后重点关注。同时,网络爬虫还可以应用在金融投资领域,比如可以自动爬取一些金融信息,进行投资分析。

有时候,可能会有几个我们比较喜欢的新闻网站,每次都要打开这些新闻网站浏览,比较麻烦。这时候就可以用网络爬虫把这多条新闻网站中的新闻信息爬下来,一起阅读。

有时,我们在浏览网页信息时,会发现有很多广告。这时候也可以使用爬虫爬取对应网页上的信息,让这些广告自动过滤掉,方便信息的阅读和使用。

有时,我们需要进行营销,因此如何找到目标客户和目标客户的联系方式是一个关键问题。我们可以在网上手动搜索,但是效率会很低。这时,我们可以使用爬虫设置相应的规则,自动从互联网上采集目标用户的联系方式等数据,用于我们的营销。

有时,我们要分析某个网站的用户信息,比如分析网站的用户活跃度、评论数、热门文章等信息。如果我们不是网站管理员,手工统计将是一个非常庞大的工程。此时就可以使用爬虫轻松获取这些数据采集进行进一步分析,而且所有的爬取操作都是自动进行的,我们只需要编写相应的爬虫,设计相应的规则就可以了。

此外,爬虫还可以实现很多强大的功能。总之,爬虫的出现在一定程度上可以替代人工访问网页。因此,我们需要手动访问互联网信息的操作现在可以通过爬虫自动化,从而可以更有效地使用互联网中的有效信息。.

3.安装第三方库

在抓取和解析数据之前,您需要在 Python 运行环境中下载并安装第三方库请求。

在Windows系统中,打开cmd(命令提示符)界面,在界面上输入pip install requests,按回车键安装。(注意网络连接)如下图

安装完成,如图

c爬虫抓取网页数据(Python爬虫大数据建模微+无忧全拼加零一)

网站优化 • 优采云 发表了文章 • 0 个评论 • 39 次浏览 • 2021-12-20 01:13

今天是一个彻头彻尾的大数据时代。大数据贯穿我们的衣食住行。可以说,大数据是目前最宝贵的数据宝藏!

什么是 Python 爬虫?

Python爬虫也叫网络爬虫

关于Python爬虫,我们需要知道:

Python 基本语法

HTML页面的内容爬取(数据爬取)

从 HTML 页面中提取数据(数据清理)

Scrapy框架和scrapy-redis分布式策略(第三方框架)

蜘蛛、反蜘蛛和反反蜘蛛之间的斗争。

网络爬虫可分为通用爬虫和聚焦爬虫。

1.通用网络爬虫

从网上采集网页,进入采集信息。此网页信息用于索引搜索引擎以提供支持。它决定了整个引擎系统的内容是否丰富,信息是否及时,因此性能的好坏直接影响搜索引擎的有效性。

2.关注爬虫

Focused crawler是一个“面向特定主题需求”的网络爬虫程序。它与一般搜索引擎爬虫的区别在于:聚焦爬虫在实现网页爬取时会对内容进行处理和过滤,并尽量保证只有爬取到的页面信息与需求页面信息相关。

运营商大数据建模捕捉微+无忧获客全拼加零一

在中国,运营商拥有庞大且绝对真实的数据资源和数据存储能力。运营商在数据利用方面的经验和经验拥有绝对的发言权。运营商的大数据,无论是大数据的抓取,数据管理,数据能力,标签能力,产品服务,这些主要业务都有突出的表现。

运营商大数据是数据变现的最佳利器!相关企业只需要利用好运营商的数据和标注能力即可。运营商的大数据平台能力将能够为相关企业提供数据服务,最终实现数据变现。运营商是数据采集、数据处理、数据分析、数据访问、数据应用等全方位的数据管理平台。一个大数据平台应该有一个标准的架构。不同的行业和企业必须与之合作。您可以将您的业务发展到一个新的高度!

数据建模

运营商一直强调数据标准化和数据可视化。通过与运营商的大数据平台合作,相关企业可以按需建模。你所有的模型都应该和你公司的业务相符,这样整个公司使用的运营商数据才有效。通过运营商大数据,所有合作伙伴都可以拥有标准的建模和优秀的数据。

数据管理

实现数据管理是所有企业的追求。中小企业很难实现自己的数据管理。如果公司做大,数据管理的成本还是会很高的。因此,运营商的大数据可以系统化、透明化。一种无障碍的方式来帮助您的公司进行数据管理。

数据应用

Python爬虫更适合依赖互联网的数据爬取。

运营商大数据可以进行有针对性的建模,进行多维度、多维度的数据抓取和数据分析。运营商大数据可抓取任意网站、网页、URL、手机APP、400电话、固话、小程序、关键词、APP新注册用户等数据信息,助力整体行业和不同企业精准获取客户,提供营销服务! 查看全部

c爬虫抓取网页数据(Python爬虫大数据建模微+无忧全拼加零一)

今天是一个彻头彻尾的大数据时代。大数据贯穿我们的衣食住行。可以说,大数据是目前最宝贵的数据宝藏!

什么是 Python 爬虫?

Python爬虫也叫网络爬虫

关于Python爬虫,我们需要知道:

Python 基本语法

HTML页面的内容爬取(数据爬取)

从 HTML 页面中提取数据(数据清理)

Scrapy框架和scrapy-redis分布式策略(第三方框架)

蜘蛛、反蜘蛛和反反蜘蛛之间的斗争。

网络爬虫可分为通用爬虫和聚焦爬虫。

1.通用网络爬虫

从网上采集网页,进入采集信息。此网页信息用于索引搜索引擎以提供支持。它决定了整个引擎系统的内容是否丰富,信息是否及时,因此性能的好坏直接影响搜索引擎的有效性。

2.关注爬虫

Focused crawler是一个“面向特定主题需求”的网络爬虫程序。它与一般搜索引擎爬虫的区别在于:聚焦爬虫在实现网页爬取时会对内容进行处理和过滤,并尽量保证只有爬取到的页面信息与需求页面信息相关。

运营商大数据建模捕捉微+无忧获客全拼加零一

在中国,运营商拥有庞大且绝对真实的数据资源和数据存储能力。运营商在数据利用方面的经验和经验拥有绝对的发言权。运营商的大数据,无论是大数据的抓取,数据管理,数据能力,标签能力,产品服务,这些主要业务都有突出的表现。

运营商大数据是数据变现的最佳利器!相关企业只需要利用好运营商的数据和标注能力即可。运营商的大数据平台能力将能够为相关企业提供数据服务,最终实现数据变现。运营商是数据采集、数据处理、数据分析、数据访问、数据应用等全方位的数据管理平台。一个大数据平台应该有一个标准的架构。不同的行业和企业必须与之合作。您可以将您的业务发展到一个新的高度!

数据建模

运营商一直强调数据标准化和数据可视化。通过与运营商的大数据平台合作,相关企业可以按需建模。你所有的模型都应该和你公司的业务相符,这样整个公司使用的运营商数据才有效。通过运营商大数据,所有合作伙伴都可以拥有标准的建模和优秀的数据。

数据管理

实现数据管理是所有企业的追求。中小企业很难实现自己的数据管理。如果公司做大,数据管理的成本还是会很高的。因此,运营商的大数据可以系统化、透明化。一种无障碍的方式来帮助您的公司进行数据管理。

数据应用

Python爬虫更适合依赖互联网的数据爬取。

运营商大数据可以进行有针对性的建模,进行多维度、多维度的数据抓取和数据分析。运营商大数据可抓取任意网站、网页、URL、手机APP、400电话、固话、小程序、关键词、APP新注册用户等数据信息,助力整体行业和不同企业精准获取客户,提供营销服务!

c爬虫抓取网页数据(Python网络爬虫反爬破解策略实战作者(组图)作者)

网站优化 • 优采云 发表了文章 • 0 个评论 • 44 次浏览 • 2021-12-17 22:34

阿里云>云栖社区>主题图>C>c网络爬虫源码

推荐活动:

更多优惠>

当前话题:c网络爬虫源码加入采集

相关话题:

c 网络爬虫源码相关博客查看更多博客

C#网络爬虫

作者:街角盒饭712人浏览评论:05年前

公司编辑妹需要抓取网页内容。我让我帮忙做一个简单的爬虫工具。这是为了抓取网页的内容。似乎这对每个人来说都不是罕见的,但这里有一些小的变化。代码在这里。请参考 1 私有字符串 GetHttpWebRequest(string url) 2 {3 Ht

阅读全文

C#HttpHelper爬虫类源码分享--苏飞版

作者:苏飞 2071人浏览评论:03年前

简介 C#HttpHelper实现了在爬取C#HttpWebRequest时忽略编码、忽略证书、忽略cookies、实现代理的功能。有了它,您可以发出 Get 和 Post 请求,还可以轻松设置 cookie、证书、代理和编码。你不关心问题,因为类会自动为你识别页面

阅读全文

Python网络爬虫反爬虫破解策略实战

作者:薇薇 8128人浏览评论:04年前

作者:薇薇转载,请注明出处。我们经常写一些网络爬虫。我想每个人都会有一种感觉。写爬虫虽然不难,但是对付反爬是比较困难的,因为大部分网站都有自己的反爬机制,所以我们爬这个数据会比较困难。但是,对于每一种反爬虫机制,我们其实都会有相应的解决方案。作为爬虫的我们,

阅读全文

C#网络爬虫增强的多线程处理

作者:街角盒饭688人浏览评论:05年前

上次给公司妹子做爬虫,不是很精致。这次需要在公司项目中用到,所以做了一些改动,功能增加了URL图片采集、下载、线程处理接口URL图片下载等。 说说思路:总理获取初始URL 采集图片到初始URL 采集链接中的初始URL的所有内容将采集中的链接放入队列继续采集图片

阅读全文

Python网络爬虫爬取最好的妹妹的视频并保存到文件中

作者:keitwotest1060人浏览评论:03年前

项目描述 使用Python编写一个网络爬虫,抓取最好的妹妹的视频并保存到文件中。示例使用工具 Python2.7.X, pycharm 如何在pycharm .py文件中创建爬取最好的妹妹的视频,并在当前目录下创建video文件夹存放抓取的视频文件,写代码,然后运行

阅读全文

一篇文章教你如何使用Python网络爬虫获取差旅攻略

作者:python进阶者13人浏览评论:01年前

【一、项目背景】侨游网提供原创实用的出境游攻略、攻略、旅游社区和问答交流平台,以及智能出行规划解决方案,以及签证、保险、机票、和酒店 在线增值服务,如预订和汽车租赁。亲游“鼓励并帮助中国游客以自己的视角和方式体验世界。” 今天教大家获取侨友网的城市信息,

阅读全文

Java版网络爬虫的基础知识(传输)

作者:developerguy851 浏览评论人数:06年前

网络爬虫不仅可以抓取网站的网页、图片,甚至还可以实现抢票、在线抢购、查询票等功能。这几天我读了一些基础知识并记录下来。网页之间的关系可以看成是一张大图,图片的遍历可以分为深度优先和广度优先。网络爬虫以广度为先,一般来说如下:2个数组,一个

阅读全文

一篇文章教你使用Python网络爬虫抓取百度贴吧评论区图片和视频

作者:pythonadvanced 26人浏览评论:01年前

【一、项目背景】百度贴吧是全球最大的中文交流平台。你像我么?有时候在评论区看到图片就想下载?或者看到视频并想下载它?今天小编就带大家在评论区搜索关键词获取图片和视频。【二、项目目标】实现将贴吧获取的图片或视频保存在

阅读全文 查看全部

c爬虫抓取网页数据(Python网络爬虫反爬破解策略实战作者(组图)作者)

阿里云>云栖社区>主题图>C>c网络爬虫源码

推荐活动:

更多优惠>

当前话题:c网络爬虫源码加入采集

相关话题:

c 网络爬虫源码相关博客查看更多博客

C#网络爬虫

作者:街角盒饭712人浏览评论:05年前

公司编辑妹需要抓取网页内容。我让我帮忙做一个简单的爬虫工具。这是为了抓取网页的内容。似乎这对每个人来说都不是罕见的,但这里有一些小的变化。代码在这里。请参考 1 私有字符串 GetHttpWebRequest(string url) 2 {3 Ht

阅读全文

C#HttpHelper爬虫类源码分享--苏飞版

作者:苏飞 2071人浏览评论:03年前

简介 C#HttpHelper实现了在爬取C#HttpWebRequest时忽略编码、忽略证书、忽略cookies、实现代理的功能。有了它,您可以发出 Get 和 Post 请求,还可以轻松设置 cookie、证书、代理和编码。你不关心问题,因为类会自动为你识别页面

阅读全文

Python网络爬虫反爬虫破解策略实战

作者:薇薇 8128人浏览评论:04年前

作者:薇薇转载,请注明出处。我们经常写一些网络爬虫。我想每个人都会有一种感觉。写爬虫虽然不难,但是对付反爬是比较困难的,因为大部分网站都有自己的反爬机制,所以我们爬这个数据会比较困难。但是,对于每一种反爬虫机制,我们其实都会有相应的解决方案。作为爬虫的我们,

阅读全文

C#网络爬虫增强的多线程处理

作者:街角盒饭688人浏览评论:05年前

上次给公司妹子做爬虫,不是很精致。这次需要在公司项目中用到,所以做了一些改动,功能增加了URL图片采集、下载、线程处理接口URL图片下载等。 说说思路:总理获取初始URL 采集图片到初始URL 采集链接中的初始URL的所有内容将采集中的链接放入队列继续采集图片

阅读全文

Python网络爬虫爬取最好的妹妹的视频并保存到文件中

作者:keitwotest1060人浏览评论:03年前

项目描述 使用Python编写一个网络爬虫,抓取最好的妹妹的视频并保存到文件中。示例使用工具 Python2.7.X, pycharm 如何在pycharm .py文件中创建爬取最好的妹妹的视频,并在当前目录下创建video文件夹存放抓取的视频文件,写代码,然后运行

阅读全文

一篇文章教你如何使用Python网络爬虫获取差旅攻略

作者:python进阶者13人浏览评论:01年前

【一、项目背景】侨游网提供原创实用的出境游攻略、攻略、旅游社区和问答交流平台,以及智能出行规划解决方案,以及签证、保险、机票、和酒店 在线增值服务,如预订和汽车租赁。亲游“鼓励并帮助中国游客以自己的视角和方式体验世界。” 今天教大家获取侨友网的城市信息,

阅读全文

Java版网络爬虫的基础知识(传输)

作者:developerguy851 浏览评论人数:06年前

网络爬虫不仅可以抓取网站的网页、图片,甚至还可以实现抢票、在线抢购、查询票等功能。这几天我读了一些基础知识并记录下来。网页之间的关系可以看成是一张大图,图片的遍历可以分为深度优先和广度优先。网络爬虫以广度为先,一般来说如下:2个数组,一个

阅读全文

一篇文章教你使用Python网络爬虫抓取百度贴吧评论区图片和视频

作者:pythonadvanced 26人浏览评论:01年前

【一、项目背景】百度贴吧是全球最大的中文交流平台。你像我么?有时候在评论区看到图片就想下载?或者看到视频并想下载它?今天小编就带大家在评论区搜索关键词获取图片和视频。【二、项目目标】实现将贴吧获取的图片或视频保存在

阅读全文

c爬虫抓取网页数据(Web网页数据抓取(C/S)繁体(c#))

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2021-12-17 22:33

网页数据捕获 (C/S) 传统

August 01, 2016-通过程序自动读取其他网站网页上显示的信息,类似于爬虫程序。比如我们有一个系统来提取百度网站歌曲搜索排名。分析系统根据获得的数据进行数据分析。为企业提供参考数据。为了满足上述要求,我们需要模拟浏览器浏览网页,获取页面的数据进行分析,最后编写分析的结构,即排序后的数据到数据库中。那

爬取网页数据分析(c#) 繁体

2008年11月26日-通过程序自动读取其他网站网页上显示的信息,类似于爬虫程序。比如我们有一个系统来提取百度网站歌曲搜索排名。分析系统根据获得的数据进行数据分析。为企业提供参考数据。为了满足上述要求,我们需要模拟浏览器浏览网页,获取页面的数据进行分析,最后编写分析的结构,即排序后的数据到数据库中。

网页数据抓取(B/S) 传统

2016年8月1日-C#爬取网页内容(转)1、爬取一般内容需要三个类:WebRequest、WebResponse、StreamReader 所需命名空间:System.Net、System.IO 核心代码:1WebRequest request = WebRequest.Create

C#爬虫,抓取网页数据

2016年9月1日-这两天学习了爬虫的基础知识,这里做一个简单的总结。抓取的网页商品数据保存在Excel表格中,效果如下: 使用Jumony Core引擎,非常强大,几乎完美的HTML解析引擎,支持css3选择器,直接抓取网页文档进行分析,并基于 HTTP 标头自动识别。博客园站点导航top信息抓取示例:var do

网页数据抓取繁体中文

2018年6月26日-1.html的常规解析 使用Jsoup包,配合开发者工具(F12)定位需要的数据路径。数据采集往往流程类似,类似的流程可以建议优化结构。2. selenium实例参考geckodriver安装:见

关于抓取网页数据!!!繁体中文

2009年3月6日-昨天去一家公司面试。老板说你回去用jsp做个项目,然后就可以上班了…… 要求是可以从指定的网页抓取需要的数据。例如:我在百度上搜索“电视”,然后我想从他返回的页面中提取他的关键词!(注:只提取客户端显示的网页数据)当我为老板提到这个话题时,我想到了“网络爬虫

网络爬虫抓取网页数据的几个常见问题

2019年2月20日-如果你想爬取数据又懒得写代码,可以试试网络爬虫爬取数据。相关文章:最简单的数据抓取教程,人人都可以用webscraper进阶教程,人人都可以使用如果你使用webscraper抓取数据,你很可能会遇到以下问题中的一个或多个,以及这些问题可能会直接打乱你的计划,甚至

网页数据抓取工具(谷歌插件web Scraper)

2018年2月11日-最简单的数据抓取教程,人人都可以使用Web Scraper是一款适合普通用户(没有专业IT技能)的免费爬虫工具,您可以轻松使用鼠标和简单的配置来获取您想要的数据。例如知乎回答列表、微博热点、微博评论、电商网站产品信息、博客文章列表等。

爬取网页数据分析繁体中文

2011.02.15-发表于 2006-05-24 14:04 北极燕鸥阅读(9793) 评论(42) 编辑采集类别:C#编程通过程序自动读取他人网站信息显示在网页上类似于一个爬虫程序,比如我们有一个系统提取百度网站歌曲搜索排名,分析系统根据得到的数据进行数据分析,为业务提供参数

抓取网页数据并解析繁体中文

2016年03月02日-这一天遇到了这样一个需求:这个页面数据能不能爬?然后提供账号、密码和网站地址: 账号:kytj1 密码:******************** 登录地址: 主要思想:1、 使用 Fiddler4 分析 HTTP 请求交互方式,包括

网页数据捕获 (C/S) 传统

August 01, 2016-通过程序自动读取其他网站网页上显示的信息,类似于爬虫程序。比如我们有一个系统来提取百度网站歌曲搜索排名。分析系统根据获得的数据进行数据分析。为企业提供参考数据。为了满足上述要求,我们需要模拟浏览器浏览网页,获取页面的数据进行分析,最后编写分析的结构,即排序后的数据到数据库中。那

爬取网页数据分析(c#) 繁体

2008年11月26日-通过程序自动读取其他网站网页上显示的信息,类似于爬虫程序。比如我们有一个系统来提取百度网站歌曲搜索排名。分析系统根据获得的数据进行数据分析。为企业提供参考数据。为了满足上述要求,我们需要模拟浏览器浏览网页,获取页面的数据进行分析,最后编写分析的结构,即排序后的数据到数据库中。

网页数据抓取(B/S) 传统

2016年8月1日-C#爬取网页内容(转)1、爬取一般内容需要三个类:WebRequest、WebResponse、StreamReader 所需命名空间:System.Net、System.IO 核心代码:1WebRequest request = WebRequest.Create

C#爬虫,抓取网页数据

2016年9月1日-这两天学习了爬虫的基础知识,这里做一个简单的总结。抓取的网页商品数据保存在Excel表格中,效果如下: 使用Jumony Core引擎,非常强大,几乎完美的HTML解析引擎,支持css3选择器,直接抓取网页文档进行分析,并基于 HTTP 标头自动识别。博客园站点导航top信息抓取示例:var do

网页数据抓取繁体中文

2018年6月26日-1.html的常规解析 使用Jsoup包,配合开发者工具(F12)定位需要的数据路径。数据采集往往流程类似,类似的流程可以建议优化结构。2. selenium实例参考geckodriver安装:见

关于抓取网页数据!!!繁体中文

2009年3月6日-昨天去一家公司面试。老板说你回去用jsp做个项目,然后就可以上班了…… 要求是可以从指定的网页抓取需要的数据。例如:我在百度上搜索“电视”,然后我想从他返回的页面中提取他的关键词!(注:只提取客户端显示的网页数据)当我为老板提到这个话题时,我想到了“网络爬虫

网络爬虫抓取网页数据的几个常见问题

2019年2月20日-如果你想爬取数据又懒得写代码,可以试试网络爬虫爬取数据。相关文章:最简单的数据抓取教程,人人都可以用webscraper进阶教程,人人都可以使用如果你使用webscraper抓取数据,你很可能会遇到以下问题中的一个或多个,以及这些问题可能会直接打乱你的计划,甚至

网页数据抓取工具(谷歌插件web Scraper)

2018年2月11日-最简单的数据抓取教程,人人都可以使用Web Scraper是一款适合普通用户(没有专业IT技能)的免费爬虫工具,您可以轻松使用鼠标和简单的配置来获取您想要的数据。例如知乎回答列表、微博热点、微博评论、电商网站产品信息、博客文章列表等。

爬取网页数据分析繁体中文

2011.02.15-发表于 2006-05-24 14:04 北极燕鸥阅读(9793) 评论(42) 编辑采集类别:C#编程通过程序自动读取他人网站信息显示在网页上类似于一个爬虫程序,比如我们有一个系统提取百度网站歌曲搜索排名,分析系统根据得到的数据进行数据分析,为业务提供参数

抓取网页数据并解析繁体中文

2016年03月02日-这一天遇到了这样一个需求:这个页面数据能不能爬?然后提供账号、密码和网站地址: 账号:kytj1 密码:******************** 登录地址: 主要思想:1、 使用 Fiddler4 分析 HTTP 请求交互方式,包括

爬取HTML网页数据繁体中文

2013年10月29日-(转)该类用于htmlparse过滤器不是通用的工具类,需要根据自己的需求来实现。这里只记录Htmlparse.jar包的一些用法。而已!有关详细信息,请参见此处:java.util.*;

使用VBA抓取网页数据繁体中文

2014年7月28日-我想用VBA捕捉以上数据,我想捕捉投资者关系信息->研究活动下每条新闻标题中的日期和新闻发布日期

Java爬取网页数据繁体中文

2013年9月23日——我最近处于辞职状态。我正赶着打发我的闲暇时间。我开始了自己的毕业设计。主题是Java Web 购物平台。我打算用SpringMVC+MyBatis来实现。我打算添加一个缓存服务器。我还没想好我会用什么。使用 Maven 进行管理

Matlab抓取网页数据繁体中文

2015年7月23日-本文示例使用正则表达式regexp进行语法识别和抓取网页数据:代码:url='#39;;[str status]=urlread(url,'Charset','GBK'); %

Matlab抓取网页数据繁体中文

2015年7月23日-本文示例使用正则表达式regexp进行语法识别和抓取网页数据:代码:url='';[str status]=urlread(url,'Charset','GBK');%Shanghai股票 suf='

JSON网页数据抓取繁体中文

2014.01.28-各位高手,如何获取以下网址的73条数据?#results/&aud=indv&type=med&state=AZ&county=Coconino&ag

python爬取网页数据传统

June 06, 2016-使用python进行简单的数据分析。在中关村在线采集数据,使用的网页是这个页面。首先,必须分析网页的 HTML。我们要捕获的数据是基于

.net 抓取网页数据 繁体中文

2015年8月3日-1、如果想通过代码获取某个页面的数据,首先根据右键查看该页面的源代码,分析一下。然后通过下面的代码,修改,一步步找出需要的内容,保存到数据库中。//根据Url地址获取网页私有字符串的html源码 GetWebContent(string Url){

C#如何抓取网页数据,分析和去除Html标签

2009年10月16日-由于这一段内容已经在我自己的搜索引擎中实现了,今天我就讲讲如何抓取网页数据,分析和去除Html标签,供大家参考。我的平台是Visual Studio2005,C#。——————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————网页

C#爬虫,繁体中文网页数据抓取笔记

2014年8月21日-第一次用C#写数据捕获,遇到各种问题。开始写模拟登录的时候,发现里面有验证码。我不得不突破验证码才能得到它。好的,那我去找验证码破解的密码。过了很长时间,我无法触摸门。我尝试了很多代码,发现它们并不通用。后来明白了原理。我先把噪点、干扰线等去掉,然后把颜色验证码变成黑色。

Python的BeautifulSoup实现抓取网页数据

2018年1月10-1日环境:pycharm,python3.42.源码分析import requests import refrom bs4 import BeautifulSoup#通过requests.get def getHtmlText(url)获取整个网页的数据:尝试:

goLang多线程抓取网页数据

2018.01.02-突然想用goLang快速爬取网页数据,于是想到了多线程页面爬取包main import("fmt""log""net/http""os""strconv""sync"

使用 HtmlAgilityPack 抓取网页数据

2013 年 12 月 31 日-XPath 使用路径表达式来选择 XML 文档中的节点或节点集。通过以下路径或步骤选择节点。下面列出了最有用的路径表达式: nodename:选择该节点的所有子节点。/:从根节点选择。//: 从匹配选择的当前节点中选择文档中的节点,而不管它们的位置。.:

浅谈抓取网页数据(提供Demo)

2014.04.09-Demo源码后台在公司做了一个比价系统,就是在网站上抓取其他产品的价格,和公司的产品对应,然后展示出来,提供给PM定价参考。后来同事的朋友找工作时,猎头让他做一个程序,抢去去哪儿最便宜的机票。然后,我帮助修复了它。这篇文章的目的就是提供这个程序的源码,然后和大家一起讨论

[.NET] 使用HtmlAgilityPack抓取网页数据繁体中文

2014年10月24日-刚学了XPath路径表达式,主要是在XML文档中搜索节点。通过 XPath 表达式,您可以快速定位和访问 XML 文档中的节点位置。HTML也是类似xml的标记语言,只是语法没有那么严谨。codeplex中有一个开源项目HtmlAgilityPack,提供了使用XPath解析HTML文档。

在Android中抓取和修改网页数据

2017-03-01-在Android中,经常使用WebView来加载网页和显示网页数据,但有时需要从网页中动态抓取数据,进行处理,甚至修改网页的数据,使其动态化显示效果,WebView 显得束手无策。最近的项目有这样的需求,加载本地H5数据,动态修改里面的内容,然后预览。接下来说一下他的实现步骤。

一个抓取网页数据的问题

2006年10月13日-我想抓取网页中的数据,但该网页禁止右键单击,查看源代码,禁止保存,甚至没有生成临时文件。一开始用的是webbrowser控件,使用documentText之类的时候报错。说找不到文件后,我用了这个HttpWebRequest request = (HttpWebRequest)

php抓取网页数据遇到的问题

2019年06月05日-1.file_get_contents无法捕获https安全协议网站使用curl获取数据函数file_get_contents_by_curl($url){$ch = curl_init();curl_setopt($ch, CURLOPT_URL, $url

winfrom 动态获取网页数据 繁体中文

2017年3月13日-我们知道如果网页的数据没有通过http协议加载到页面中,或者ajax延迟加载数据到页面,这时候你的请求url获取到的数据语言不全,说白了就是如果不能抓取到需要的目标数据,就用下面两种方法处理: 方法一:WebBrowser延迟加载采集地址(线程等待)用js处理。1.目标网址:

[.NET] 使用HtmlAgilityPack抓取网页数据繁体中文

2017年7月14日-刚学了XPath路径表达式,主要是在XML文档中搜索节点。通过 XPath 表达式,您可以快速定位和访问 XML 文档中的节点位置。HTML也是类似xml的标记语言,只是语法没有那么严谨。codeplex中有一个开源项目HtmlAgilityPack,提供了使用XPath解析HTML文档。

Java抓取网页数据,登录后抓取数据。繁体中文

2014年10月20日——最近做了一个小程序,从网上抓取数据。主要是关于信用,一些黑名单网站采集,从网站抓取到我们自己的系统。我也找到了一些资料,但我认为没有一个很好的和全面的例子。所以在这里做个笔记以提醒自己。首先需要一个jsoup jar包,我用的是1.6.0。. 下载地址为:

.net2.0 抓取网页数据分析繁体中文

2006年11月22日-效果图后台代码如下:using System;使用 System.Data; 使用 System.Configuration; 使用 System.Web;使用 System.Web.Security;

使用webbrowser控件抓取网页数据,如何抓取多个a标签的url地址对应的网页数据

2011.05.20-由于标题所属,我的页面有四个菜单,分别连接到不同的地址。我现在想用一个按钮来抓取这个页面的数据。在抓取时,我遍历获取了四个 a 标签 url 地址。然后自动进入对应页面抓取数据并保存到数据库中。现在问题如下: ArrayList UrlList = new ArrayList();

Java抓取网页数据(原网页+Javascript返回数据)

2014年05月07日-原文链接:有时由于各种原因,我们需要采集某个网站数据,但由于不同网站数据显示方式略有不同!本文用Java来告诉你如何捕获网站的数量

Java抓取网页数据(原网页+Javascript返回数据)

2012年8月26日-转载请注明出处!原文链接:有时由于各种原因,我们需要采集某个网站数据,但由于不同网站数据显示方式略有不同!本文使用Java向大家展示如何抓取网站的数据:(1)

网页数据抓取,网页源代码没有需要的数据

2014.10.04-在使用WebClient抓取网页数据时,查看了网页的源码,发现源码中没有网页上可以看到的数据。这种情况下,是不是意味着网页上的数据是通过JS返回的?那么,在这种情况下,您如何提取所需的数据?

谁能抓取一个C#网页数据的源代码,最好是完整的?繁体

2012年12月12日-如何使用C#从类似于搜狐的页面中抓取标题、作者和日期?爬取次数不少于10次。请高手指点,最好能给出完整的源代码?

C#抓取网页数据,分析去除HTML标签【转】繁体

August 09, 2010-首先抓取网页的全部内容,将数据放入byte[]中(网络传输时格式为byte),然后转换为String,方便操作。示例如下: private static string GetPageData (string url){ if (url == null || url.Trim() =

【工作笔记0006】C#调用HtmlAgilityPack类库实现网页数据抓取繁体中文

2015年7月30日-最近在研究HtmlAgilityPack,发现它的类库功能非常强大,非常方便的实现网页数据抓取。下面是一个使用 HtmlAgilityPack 捕获数据的简单示例。目标是抓取我个人博客的文章列表数据。路径如下:adamlevine7个人博客目录核心代码如下:1.第一次参考

C#抓取网页数据,分析(如抓取天气预报) 091016 有更新 091110 再次更新 繁体

2009年8月12日-先看这位大哥的博客。最好先抓取网页的全部内容,将数据放入byte[]中(网络传输时格式为byte),然后再转换为String,方便比较。操作示例如下: private static string GetPageData(string url){ if (url == n

使用 node.js cheerio 抓取网页数据

2015年9月29日-你是想自动抓取网页中的一些数据还是想把从什么博客中提取的数据转换成结构化数据?有没有现有的 API 来检索数据?!!!!@#$@#$...可以解决网页爬虫问题。什么是网络爬虫?你可能会问。. . 网页抓取是一种以编程方式(通常无需浏览器参与)检索网页内容并从中提取数据的过程。这篇论文,小

Java程序抓取网页数据和去重处理

2014年08月05日-如题,等回复,最好带程序,带个大概说明,新手,网上爬虫看起来很简单。

为什么我不能用Delphi抓取网页数据?

2015.06.08-我用delphi自带的IdHttp idhttp1.Get('')来抓取这个网页的数据。为什么我不能抓取下面的数据?有什么好的方法可以做到吗?

8、多级网页数据抓取繁体中文

2013 年 7 月 31 日-使用 System;using System.采集s.Generic;using System.ComponentModel;using System.Data;using System.Drawing;using System.Text;using System.Window

谁有登录后抓取网页数据的例子?

2010 年 12 月 8 日 - 现在迫切需要一个这样的例子,过去两天我一直很伤心。登录包括使用用户名、密码和验证码登录。只需能够完成登录步骤。登录是手动输入登录

Python中使用PhantomJS抓取Javascript网页数据

2015年07月01日-有些网页不是静态加载的,而是通过javascipt函数动态加载的。例如,在下面的网页中,通过javascirpt函数从后台加载了表中看涨合约和看跌合约的数据。仅使用beautifulsoup 无法捕获此表中的数据。找资料,发现可以用PhantomJS来爬取此类网页

网页爬虫-使用Python爬取网页数据繁体中文

2015年8月24日-干货搬家大神童熊!我没有事儿。我看了一下 Python,发现它很酷。废话少说,准备搭建环境。因为是MAC电脑,所以自动安装Python2.7版本并添加库Beautiful Soup,这里有两种方法

网页数据采集系统解决方案 传统

2009年12月29日-1. 项目介绍 项目背景 互联网时代,信息海阔天空。甚至我们获取信息的方式也发生了变化:从传统的翻书到查字典,再到通过搜索引擎搜索。我们已经从信息匮乏的时代走到了信息丰富的今天。今天,困扰我们的问题不是信息太少,而是太多太多,让你无法分辨或选择。因此,提供一个

Node.js 使用cheerio 抓取网页数据DEMO

2015年07月28日-Node.js原本是作为Js服务器使用的,现在一起用它来做个爬虫吧。关键是爬取网页后如何得到你想要的数据?然后我找到了cheerio,解析html非常方便,就像在浏览器中使用jquery一样。使用以下命令安装cheerio [C#]纯文本视图复制代码?01npm 安装

R语言实现简单的网页数据抓取繁体中文

2017年2月17日-我在知乎遇到这样的问题。这是要爬取的内容的网页: R语言代码的实现如下:#Install XML package>install.packages("XML")#Load XML package>

Jsoup介绍-使用Java抓取网页数据

2014年10月15日-转载请注明出处:概述jsoup是一个Java HTML解析器,可以直接解析一个URL地址和HTML文本内容。它提供了一个非常省力的 API,通过 DOM、CSS 和类 查看全部

c爬虫抓取网页数据(Web网页数据抓取(C/S)繁体(c#))

网页数据捕获 (C/S) 传统

August 01, 2016-通过程序自动读取其他网站网页上显示的信息,类似于爬虫程序。比如我们有一个系统来提取百度网站歌曲搜索排名。分析系统根据获得的数据进行数据分析。为企业提供参考数据。为了满足上述要求,我们需要模拟浏览器浏览网页,获取页面的数据进行分析,最后编写分析的结构,即排序后的数据到数据库中。那

爬取网页数据分析(c#) 繁体

2008年11月26日-通过程序自动读取其他网站网页上显示的信息,类似于爬虫程序。比如我们有一个系统来提取百度网站歌曲搜索排名。分析系统根据获得的数据进行数据分析。为企业提供参考数据。为了满足上述要求,我们需要模拟浏览器浏览网页,获取页面的数据进行分析,最后编写分析的结构,即排序后的数据到数据库中。

网页数据抓取(B/S) 传统

2016年8月1日-C#爬取网页内容(转)1、爬取一般内容需要三个类:WebRequest、WebResponse、StreamReader 所需命名空间:System.Net、System.IO 核心代码:1WebRequest request = WebRequest.Create

C#爬虫,抓取网页数据

2016年9月1日-这两天学习了爬虫的基础知识,这里做一个简单的总结。抓取的网页商品数据保存在Excel表格中,效果如下: 使用Jumony Core引擎,非常强大,几乎完美的HTML解析引擎,支持css3选择器,直接抓取网页文档进行分析,并基于 HTTP 标头自动识别。博客园站点导航top信息抓取示例:var do

网页数据抓取繁体中文

2018年6月26日-1.html的常规解析 使用Jsoup包,配合开发者工具(F12)定位需要的数据路径。数据采集往往流程类似,类似的流程可以建议优化结构。2. selenium实例参考geckodriver安装:见

关于抓取网页数据!!!繁体中文

2009年3月6日-昨天去一家公司面试。老板说你回去用jsp做个项目,然后就可以上班了…… 要求是可以从指定的网页抓取需要的数据。例如:我在百度上搜索“电视”,然后我想从他返回的页面中提取他的关键词!(注:只提取客户端显示的网页数据)当我为老板提到这个话题时,我想到了“网络爬虫

网络爬虫抓取网页数据的几个常见问题

2019年2月20日-如果你想爬取数据又懒得写代码,可以试试网络爬虫爬取数据。相关文章:最简单的数据抓取教程,人人都可以用webscraper进阶教程,人人都可以使用如果你使用webscraper抓取数据,你很可能会遇到以下问题中的一个或多个,以及这些问题可能会直接打乱你的计划,甚至

网页数据抓取工具(谷歌插件web Scraper)

2018年2月11日-最简单的数据抓取教程,人人都可以使用Web Scraper是一款适合普通用户(没有专业IT技能)的免费爬虫工具,您可以轻松使用鼠标和简单的配置来获取您想要的数据。例如知乎回答列表、微博热点、微博评论、电商网站产品信息、博客文章列表等。

爬取网页数据分析繁体中文

2011.02.15-发表于 2006-05-24 14:04 北极燕鸥阅读(9793) 评论(42) 编辑采集类别:C#编程通过程序自动读取他人网站信息显示在网页上类似于一个爬虫程序,比如我们有一个系统提取百度网站歌曲搜索排名,分析系统根据得到的数据进行数据分析,为业务提供参数

抓取网页数据并解析繁体中文

2016年03月02日-这一天遇到了这样一个需求:这个页面数据能不能爬?然后提供账号、密码和网站地址: 账号:kytj1 密码:******************** 登录地址: 主要思想:1、 使用 Fiddler4 分析 HTTP 请求交互方式,包括

网页数据捕获 (C/S) 传统

August 01, 2016-通过程序自动读取其他网站网页上显示的信息,类似于爬虫程序。比如我们有一个系统来提取百度网站歌曲搜索排名。分析系统根据获得的数据进行数据分析。为企业提供参考数据。为了满足上述要求,我们需要模拟浏览器浏览网页,获取页面的数据进行分析,最后编写分析的结构,即排序后的数据到数据库中。那

爬取网页数据分析(c#) 繁体

2008年11月26日-通过程序自动读取其他网站网页上显示的信息,类似于爬虫程序。比如我们有一个系统来提取百度网站歌曲搜索排名。分析系统根据获得的数据进行数据分析。为企业提供参考数据。为了满足上述要求,我们需要模拟浏览器浏览网页,获取页面的数据进行分析,最后编写分析的结构,即排序后的数据到数据库中。

网页数据抓取(B/S) 传统

2016年8月1日-C#爬取网页内容(转)1、爬取一般内容需要三个类:WebRequest、WebResponse、StreamReader 所需命名空间:System.Net、System.IO 核心代码:1WebRequest request = WebRequest.Create

C#爬虫,抓取网页数据

2016年9月1日-这两天学习了爬虫的基础知识,这里做一个简单的总结。抓取的网页商品数据保存在Excel表格中,效果如下: 使用Jumony Core引擎,非常强大,几乎完美的HTML解析引擎,支持css3选择器,直接抓取网页文档进行分析,并基于 HTTP 标头自动识别。博客园站点导航top信息抓取示例:var do

网页数据抓取繁体中文

2018年6月26日-1.html的常规解析 使用Jsoup包,配合开发者工具(F12)定位需要的数据路径。数据采集往往流程类似,类似的流程可以建议优化结构。2. selenium实例参考geckodriver安装:见

关于抓取网页数据!!!繁体中文

2009年3月6日-昨天去一家公司面试。老板说你回去用jsp做个项目,然后就可以上班了…… 要求是可以从指定的网页抓取需要的数据。例如:我在百度上搜索“电视”,然后我想从他返回的页面中提取他的关键词!(注:只提取客户端显示的网页数据)当我为老板提到这个话题时,我想到了“网络爬虫

网络爬虫抓取网页数据的几个常见问题

2019年2月20日-如果你想爬取数据又懒得写代码,可以试试网络爬虫爬取数据。相关文章:最简单的数据抓取教程,人人都可以用webscraper进阶教程,人人都可以使用如果你使用webscraper抓取数据,你很可能会遇到以下问题中的一个或多个,以及这些问题可能会直接打乱你的计划,甚至

网页数据抓取工具(谷歌插件web Scraper)

2018年2月11日-最简单的数据抓取教程,人人都可以使用Web Scraper是一款适合普通用户(没有专业IT技能)的免费爬虫工具,您可以轻松使用鼠标和简单的配置来获取您想要的数据。例如知乎回答列表、微博热点、微博评论、电商网站产品信息、博客文章列表等。

爬取网页数据分析繁体中文

2011.02.15-发表于 2006-05-24 14:04 北极燕鸥阅读(9793) 评论(42) 编辑采集类别:C#编程通过程序自动读取他人网站信息显示在网页上类似于一个爬虫程序,比如我们有一个系统提取百度网站歌曲搜索排名,分析系统根据得到的数据进行数据分析,为业务提供参数

抓取网页数据并解析繁体中文

2016年03月02日-这一天遇到了这样一个需求:这个页面数据能不能爬?然后提供账号、密码和网站地址: 账号:kytj1 密码:******************** 登录地址: 主要思想:1、 使用 Fiddler4 分析 HTTP 请求交互方式,包括

爬取HTML网页数据繁体中文

2013年10月29日-(转)该类用于htmlparse过滤器不是通用的工具类,需要根据自己的需求来实现。这里只记录Htmlparse.jar包的一些用法。而已!有关详细信息,请参见此处:java.util.*;

使用VBA抓取网页数据繁体中文

2014年7月28日-我想用VBA捕捉以上数据,我想捕捉投资者关系信息->研究活动下每条新闻标题中的日期和新闻发布日期

Java爬取网页数据繁体中文

2013年9月23日——我最近处于辞职状态。我正赶着打发我的闲暇时间。我开始了自己的毕业设计。主题是Java Web 购物平台。我打算用SpringMVC+MyBatis来实现。我打算添加一个缓存服务器。我还没想好我会用什么。使用 Maven 进行管理

Matlab抓取网页数据繁体中文

2015年7月23日-本文示例使用正则表达式regexp进行语法识别和抓取网页数据:代码:url='#39;;[str status]=urlread(url,'Charset','GBK'); %

Matlab抓取网页数据繁体中文

2015年7月23日-本文示例使用正则表达式regexp进行语法识别和抓取网页数据:代码:url='';[str status]=urlread(url,'Charset','GBK');%Shanghai股票 suf='

JSON网页数据抓取繁体中文

2014.01.28-各位高手,如何获取以下网址的73条数据?#results/&aud=indv&type=med&state=AZ&county=Coconino&ag

python爬取网页数据传统

June 06, 2016-使用python进行简单的数据分析。在中关村在线采集数据,使用的网页是这个页面。首先,必须分析网页的 HTML。我们要捕获的数据是基于

.net 抓取网页数据 繁体中文

2015年8月3日-1、如果想通过代码获取某个页面的数据,首先根据右键查看该页面的源代码,分析一下。然后通过下面的代码,修改,一步步找出需要的内容,保存到数据库中。//根据Url地址获取网页私有字符串的html源码 GetWebContent(string Url){

C#如何抓取网页数据,分析和去除Html标签

2009年10月16日-由于这一段内容已经在我自己的搜索引擎中实现了,今天我就讲讲如何抓取网页数据,分析和去除Html标签,供大家参考。我的平台是Visual Studio2005,C#。——————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————网页

C#爬虫,繁体中文网页数据抓取笔记

2014年8月21日-第一次用C#写数据捕获,遇到各种问题。开始写模拟登录的时候,发现里面有验证码。我不得不突破验证码才能得到它。好的,那我去找验证码破解的密码。过了很长时间,我无法触摸门。我尝试了很多代码,发现它们并不通用。后来明白了原理。我先把噪点、干扰线等去掉,然后把颜色验证码变成黑色。

Python的BeautifulSoup实现抓取网页数据

2018年1月10-1日环境:pycharm,python3.42.源码分析import requests import refrom bs4 import BeautifulSoup#通过requests.get def getHtmlText(url)获取整个网页的数据:尝试:

goLang多线程抓取网页数据

2018.01.02-突然想用goLang快速爬取网页数据,于是想到了多线程页面爬取包main import("fmt""log""net/http""os""strconv""sync"

使用 HtmlAgilityPack 抓取网页数据

2013 年 12 月 31 日-XPath 使用路径表达式来选择 XML 文档中的节点或节点集。通过以下路径或步骤选择节点。下面列出了最有用的路径表达式: nodename:选择该节点的所有子节点。/:从根节点选择。//: 从匹配选择的当前节点中选择文档中的节点,而不管它们的位置。.:

浅谈抓取网页数据(提供Demo)

2014.04.09-Demo源码后台在公司做了一个比价系统,就是在网站上抓取其他产品的价格,和公司的产品对应,然后展示出来,提供给PM定价参考。后来同事的朋友找工作时,猎头让他做一个程序,抢去去哪儿最便宜的机票。然后,我帮助修复了它。这篇文章的目的就是提供这个程序的源码,然后和大家一起讨论

[.NET] 使用HtmlAgilityPack抓取网页数据繁体中文

2014年10月24日-刚学了XPath路径表达式,主要是在XML文档中搜索节点。通过 XPath 表达式,您可以快速定位和访问 XML 文档中的节点位置。HTML也是类似xml的标记语言,只是语法没有那么严谨。codeplex中有一个开源项目HtmlAgilityPack,提供了使用XPath解析HTML文档。

在Android中抓取和修改网页数据

2017-03-01-在Android中,经常使用WebView来加载网页和显示网页数据,但有时需要从网页中动态抓取数据,进行处理,甚至修改网页的数据,使其动态化显示效果,WebView 显得束手无策。最近的项目有这样的需求,加载本地H5数据,动态修改里面的内容,然后预览。接下来说一下他的实现步骤。

一个抓取网页数据的问题

2006年10月13日-我想抓取网页中的数据,但该网页禁止右键单击,查看源代码,禁止保存,甚至没有生成临时文件。一开始用的是webbrowser控件,使用documentText之类的时候报错。说找不到文件后,我用了这个HttpWebRequest request = (HttpWebRequest)

php抓取网页数据遇到的问题

2019年06月05日-1.file_get_contents无法捕获https安全协议网站使用curl获取数据函数file_get_contents_by_curl($url){$ch = curl_init();curl_setopt($ch, CURLOPT_URL, $url

winfrom 动态获取网页数据 繁体中文

2017年3月13日-我们知道如果网页的数据没有通过http协议加载到页面中,或者ajax延迟加载数据到页面,这时候你的请求url获取到的数据语言不全,说白了就是如果不能抓取到需要的目标数据,就用下面两种方法处理: 方法一:WebBrowser延迟加载采集地址(线程等待)用js处理。1.目标网址:

[.NET] 使用HtmlAgilityPack抓取网页数据繁体中文

2017年7月14日-刚学了XPath路径表达式,主要是在XML文档中搜索节点。通过 XPath 表达式,您可以快速定位和访问 XML 文档中的节点位置。HTML也是类似xml的标记语言,只是语法没有那么严谨。codeplex中有一个开源项目HtmlAgilityPack,提供了使用XPath解析HTML文档。

Java抓取网页数据,登录后抓取数据。繁体中文

2014年10月20日——最近做了一个小程序,从网上抓取数据。主要是关于信用,一些黑名单网站采集,从网站抓取到我们自己的系统。我也找到了一些资料,但我认为没有一个很好的和全面的例子。所以在这里做个笔记以提醒自己。首先需要一个jsoup jar包,我用的是1.6.0。. 下载地址为:

.net2.0 抓取网页数据分析繁体中文

2006年11月22日-效果图后台代码如下:using System;使用 System.Data; 使用 System.Configuration; 使用 System.Web;使用 System.Web.Security;

使用webbrowser控件抓取网页数据,如何抓取多个a标签的url地址对应的网页数据

2011.05.20-由于标题所属,我的页面有四个菜单,分别连接到不同的地址。我现在想用一个按钮来抓取这个页面的数据。在抓取时,我遍历获取了四个 a 标签 url 地址。然后自动进入对应页面抓取数据并保存到数据库中。现在问题如下: ArrayList UrlList = new ArrayList();

Java抓取网页数据(原网页+Javascript返回数据)

2014年05月07日-原文链接:有时由于各种原因,我们需要采集某个网站数据,但由于不同网站数据显示方式略有不同!本文用Java来告诉你如何捕获网站的数量

Java抓取网页数据(原网页+Javascript返回数据)

2012年8月26日-转载请注明出处!原文链接:有时由于各种原因,我们需要采集某个网站数据,但由于不同网站数据显示方式略有不同!本文使用Java向大家展示如何抓取网站的数据:(1)

网页数据抓取,网页源代码没有需要的数据

2014.10.04-在使用WebClient抓取网页数据时,查看了网页的源码,发现源码中没有网页上可以看到的数据。这种情况下,是不是意味着网页上的数据是通过JS返回的?那么,在这种情况下,您如何提取所需的数据?

谁能抓取一个C#网页数据的源代码,最好是完整的?繁体

2012年12月12日-如何使用C#从类似于搜狐的页面中抓取标题、作者和日期?爬取次数不少于10次。请高手指点,最好能给出完整的源代码?

C#抓取网页数据,分析去除HTML标签【转】繁体

August 09, 2010-首先抓取网页的全部内容,将数据放入byte[]中(网络传输时格式为byte),然后转换为String,方便操作。示例如下: private static string GetPageData (string url){ if (url == null || url.Trim() =

【工作笔记0006】C#调用HtmlAgilityPack类库实现网页数据抓取繁体中文

2015年7月30日-最近在研究HtmlAgilityPack,发现它的类库功能非常强大,非常方便的实现网页数据抓取。下面是一个使用 HtmlAgilityPack 捕获数据的简单示例。目标是抓取我个人博客的文章列表数据。路径如下:adamlevine7个人博客目录核心代码如下:1.第一次参考

C#抓取网页数据,分析(如抓取天气预报) 091016 有更新 091110 再次更新 繁体

2009年8月12日-先看这位大哥的博客。最好先抓取网页的全部内容,将数据放入byte[]中(网络传输时格式为byte),然后再转换为String,方便比较。操作示例如下: private static string GetPageData(string url){ if (url == n

使用 node.js cheerio 抓取网页数据

2015年9月29日-你是想自动抓取网页中的一些数据还是想把从什么博客中提取的数据转换成结构化数据?有没有现有的 API 来检索数据?!!!!@#$@#$...可以解决网页爬虫问题。什么是网络爬虫?你可能会问。. . 网页抓取是一种以编程方式(通常无需浏览器参与)检索网页内容并从中提取数据的过程。这篇论文,小

Java程序抓取网页数据和去重处理

2014年08月05日-如题,等回复,最好带程序,带个大概说明,新手,网上爬虫看起来很简单。

为什么我不能用Delphi抓取网页数据?

2015.06.08-我用delphi自带的IdHttp idhttp1.Get('')来抓取这个网页的数据。为什么我不能抓取下面的数据?有什么好的方法可以做到吗?

8、多级网页数据抓取繁体中文

2013 年 7 月 31 日-使用 System;using System.采集s.Generic;using System.ComponentModel;using System.Data;using System.Drawing;using System.Text;using System.Window

谁有登录后抓取网页数据的例子?

2010 年 12 月 8 日 - 现在迫切需要一个这样的例子,过去两天我一直很伤心。登录包括使用用户名、密码和验证码登录。只需能够完成登录步骤。登录是手动输入登录

Python中使用PhantomJS抓取Javascript网页数据

2015年07月01日-有些网页不是静态加载的,而是通过javascipt函数动态加载的。例如,在下面的网页中,通过javascirpt函数从后台加载了表中看涨合约和看跌合约的数据。仅使用beautifulsoup 无法捕获此表中的数据。找资料,发现可以用PhantomJS来爬取此类网页

网页爬虫-使用Python爬取网页数据繁体中文

2015年8月24日-干货搬家大神童熊!我没有事儿。我看了一下 Python,发现它很酷。废话少说,准备搭建环境。因为是MAC电脑,所以自动安装Python2.7版本并添加库Beautiful Soup,这里有两种方法

网页数据采集系统解决方案 传统

2009年12月29日-1. 项目介绍 项目背景 互联网时代,信息海阔天空。甚至我们获取信息的方式也发生了变化:从传统的翻书到查字典,再到通过搜索引擎搜索。我们已经从信息匮乏的时代走到了信息丰富的今天。今天,困扰我们的问题不是信息太少,而是太多太多,让你无法分辨或选择。因此,提供一个

Node.js 使用cheerio 抓取网页数据DEMO

2015年07月28日-Node.js原本是作为Js服务器使用的,现在一起用它来做个爬虫吧。关键是爬取网页后如何得到你想要的数据?然后我找到了cheerio,解析html非常方便,就像在浏览器中使用jquery一样。使用以下命令安装cheerio [C#]纯文本视图复制代码?01npm 安装

R语言实现简单的网页数据抓取繁体中文

2017年2月17日-我在知乎遇到这样的问题。这是要爬取的内容的网页: R语言代码的实现如下:#Install XML package>install.packages("XML")#Load XML package>

Jsoup介绍-使用Java抓取网页数据

2014年10月15日-转载请注明出处:概述jsoup是一个Java HTML解析器,可以直接解析一个URL地址和HTML文本内容。它提供了一个非常省力的 API,通过 DOM、CSS 和类

c爬虫抓取网页数据( SEO优化工作的6个策略之前)

网站优化 • 优采云 发表了文章 • 0 个评论 • 35 次浏览 • 2021-12-16 16:16

SEO优化工作的6个策略之前)

搜索引擎爬虫抓取我们的网页是实现 SEO 优化的第一步。如果不爬取,网站就不会搜索到收录,也就没有排名。所以对于每一个SEO从业者来说,爬行是第一步!

事实上,大多数SEO从业者所知道的搜索引擎爬取算法只有深度优先和广度优先的爬取策略。但实际上,爬虫爬取的网页有6种策略。在分享这6个策略之前,你必须先看看搜索引擎爬虫的工作流程,否则你可能看不懂下面的内容。

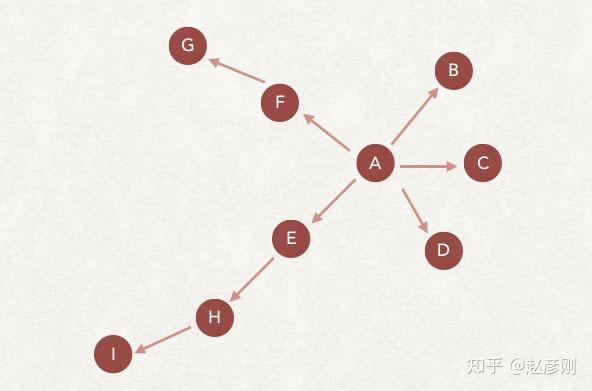

爬虫的宽度优先爬取策略

广度优先的爬取策略,一种历史悠久,一直受到关注的爬取策略。搜索引擎爬虫诞生以来就一直在使用的爬虫策略,甚至很多新的策略都是以此为基础的。

广度优先的爬取策略是根据要爬取的URL列表进行爬取。新发现的并判断为未爬取的链接,基本上直接存放在待爬取的URL列表末尾,等待被爬取。

如上图,我们假设爬虫的待爬取的URL列表中只有A。爬虫从A网页开始爬取,从A中提取B、C、D网页,然后将B、C、D放入爬取队列,然后获取E、F、G、H、I页面依次插入到要爬取的URL列表中,以此类推。

Crawler的深度优先爬取策略

深度优先抓取的策略是,爬虫会从待抓取列表中抓取第一个网址,然后沿着这个网址继续抓取该页面的其他网址,直到该行处理完毕,再从待抓取列表中抓取, 抢第二个,依此类推。下面给出了一个说明。

作为列表中第一个要爬取的 URL,爬虫开始爬取,然后爬到 B、C、D、E、F,但是 B、C、D 中没有后续链接(这里也会删除了已经爬过的页面),从E中找到H,跟着H,找到I,然后就没有了。在F中找到G,那么这个链接的爬取就结束了。从要获取的列表中,获取下一个链接继续上述操作。

Crawler 不完整的 PageRank 爬取策略

相信很多人都知道PageRank算法。我们SEO的白话理解就是链接传递权重的算法。而如果应用于爬虫爬行,又是怎样的逻辑呢?首先,爬虫的目的是下载网页。同时,爬虫无法看到指向某个网页的所有链接。因此,在爬取过程中,爬虫无法计算所有网页的pagerank,从而导致爬行。过程中计算出的pagerank不太可靠。

非完全pagerank爬取策略是基于爬虫无法看到某个页面的所有链接,而只能看到部分情况,必须进行pagerank计算结果。

它的具体策略是将已下载的网页和要爬取的URL列表中的网页形成一个汇总。在此摘要中执行 pagerank 计算。计算完成后,待爬取的URL列表中的每个URL都会得到一个pagerank值,然后根据这个值进行倒序排序。先获取最高的pagerank分数,然后一一获取。

这是问题吗?在要爬取的URL列表中,如果最后添加了新的URL,是否需要重新计算?

不是这种情况。搜索引擎会等到待抓取的网址列表中的新网址达到一定数量后,才会重新抓取。这样效率会提高很多。毕竟,爬虫抓取第一个添加的需要时间。

Crawler的OPIC爬取策略

OPIC是在线页面重要性计算的缩写,意思是“在线页面重要性计算”。这是pagerank的升级版。

它的具体策略逻辑是爬虫给互联网上的所有网址分配一个初始分数,每个网址的分数相同。每次下载一个网页时,该网页的分数都会平均分配给该网页中的所有链接。自然而然,这个页面的分数就会被清零。对于要爬取的URL列表(当然,刚才的网页被清空了分数,也是因为已经爬过了),首先爬取的是谁的分数最高。

与pagerank不同,opic是实时计算的。这里提醒我们,如果我们只考虑opic的爬取策略。这个策略和pagerank策略都证实了一个逻辑。我们新生成的网页,被链接的次数越多,被抓取的概率就越大。

是否值得考虑您的网页布局?

爬虫爬取的大站点优先策略

大网站优先爬取,是不是顾名思义?大的网站会先爬吗?但这里有两种解释。我个人认为这两个解释爬虫都在使用。

大站优先爬取说明1:顾名思义,爬虫会对列表中要爬取的URL进行分类,然后确定域名对应的网站级别。比如优先抓取权重较大的网站域名。

大展优先爬取说明2:爬虫根据域名对列表中要爬取的URL进行分类,然后计算数量。它所属的域是待抓取列表中编号最大的域。

两种解释,一种是网站的权重高,另一种是每天发布的文章数量多,发布非常集中。但是让我们想象一下,发布如此集中和如此多文章的网站通常都是大网站,对吗?

我们在这里想什么?

写文章时,一定要及时推送到搜索引擎。一小时不能发一篇,太散了。不过这个还是要验证的,有经验的同学可以考一下。 查看全部

c爬虫抓取网页数据(

SEO优化工作的6个策略之前)

搜索引擎爬虫抓取我们的网页是实现 SEO 优化的第一步。如果不爬取,网站就不会搜索到收录,也就没有排名。所以对于每一个SEO从业者来说,爬行是第一步!

事实上,大多数SEO从业者所知道的搜索引擎爬取算法只有深度优先和广度优先的爬取策略。但实际上,爬虫爬取的网页有6种策略。在分享这6个策略之前,你必须先看看搜索引擎爬虫的工作流程,否则你可能看不懂下面的内容。

爬虫的宽度优先爬取策略

广度优先的爬取策略,一种历史悠久,一直受到关注的爬取策略。搜索引擎爬虫诞生以来就一直在使用的爬虫策略,甚至很多新的策略都是以此为基础的。

广度优先的爬取策略是根据要爬取的URL列表进行爬取。新发现的并判断为未爬取的链接,基本上直接存放在待爬取的URL列表末尾,等待被爬取。

如上图,我们假设爬虫的待爬取的URL列表中只有A。爬虫从A网页开始爬取,从A中提取B、C、D网页,然后将B、C、D放入爬取队列,然后获取E、F、G、H、I页面依次插入到要爬取的URL列表中,以此类推。

Crawler的深度优先爬取策略

深度优先抓取的策略是,爬虫会从待抓取列表中抓取第一个网址,然后沿着这个网址继续抓取该页面的其他网址,直到该行处理完毕,再从待抓取列表中抓取, 抢第二个,依此类推。下面给出了一个说明。

作为列表中第一个要爬取的 URL,爬虫开始爬取,然后爬到 B、C、D、E、F,但是 B、C、D 中没有后续链接(这里也会删除了已经爬过的页面),从E中找到H,跟着H,找到I,然后就没有了。在F中找到G,那么这个链接的爬取就结束了。从要获取的列表中,获取下一个链接继续上述操作。

Crawler 不完整的 PageRank 爬取策略

相信很多人都知道PageRank算法。我们SEO的白话理解就是链接传递权重的算法。而如果应用于爬虫爬行,又是怎样的逻辑呢?首先,爬虫的目的是下载网页。同时,爬虫无法看到指向某个网页的所有链接。因此,在爬取过程中,爬虫无法计算所有网页的pagerank,从而导致爬行。过程中计算出的pagerank不太可靠。

非完全pagerank爬取策略是基于爬虫无法看到某个页面的所有链接,而只能看到部分情况,必须进行pagerank计算结果。

它的具体策略是将已下载的网页和要爬取的URL列表中的网页形成一个汇总。在此摘要中执行 pagerank 计算。计算完成后,待爬取的URL列表中的每个URL都会得到一个pagerank值,然后根据这个值进行倒序排序。先获取最高的pagerank分数,然后一一获取。

这是问题吗?在要爬取的URL列表中,如果最后添加了新的URL,是否需要重新计算?

不是这种情况。搜索引擎会等到待抓取的网址列表中的新网址达到一定数量后,才会重新抓取。这样效率会提高很多。毕竟,爬虫抓取第一个添加的需要时间。

Crawler的OPIC爬取策略

OPIC是在线页面重要性计算的缩写,意思是“在线页面重要性计算”。这是pagerank的升级版。

它的具体策略逻辑是爬虫给互联网上的所有网址分配一个初始分数,每个网址的分数相同。每次下载一个网页时,该网页的分数都会平均分配给该网页中的所有链接。自然而然,这个页面的分数就会被清零。对于要爬取的URL列表(当然,刚才的网页被清空了分数,也是因为已经爬过了),首先爬取的是谁的分数最高。

与pagerank不同,opic是实时计算的。这里提醒我们,如果我们只考虑opic的爬取策略。这个策略和pagerank策略都证实了一个逻辑。我们新生成的网页,被链接的次数越多,被抓取的概率就越大。

是否值得考虑您的网页布局?

爬虫爬取的大站点优先策略

大网站优先爬取,是不是顾名思义?大的网站会先爬吗?但这里有两种解释。我个人认为这两个解释爬虫都在使用。

大站优先爬取说明1:顾名思义,爬虫会对列表中要爬取的URL进行分类,然后确定域名对应的网站级别。比如优先抓取权重较大的网站域名。

大展优先爬取说明2:爬虫根据域名对列表中要爬取的URL进行分类,然后计算数量。它所属的域是待抓取列表中编号最大的域。

两种解释,一种是网站的权重高,另一种是每天发布的文章数量多,发布非常集中。但是让我们想象一下,发布如此集中和如此多文章的网站通常都是大网站,对吗?

我们在这里想什么?

写文章时,一定要及时推送到搜索引擎。一小时不能发一篇,太散了。不过这个还是要验证的,有经验的同学可以考一下。

c爬虫抓取网页数据(c爬虫抓取网页数据,网页代码动态加载的,可控)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2021-12-16 01:04

c爬虫抓取网页数据,运行简单即可。无需搭建环境,不需要采用大型机,也无需编写代码。仅用到小白看的懂的理论知识。思路:本爬虫简单的抓取网页数据,网页代码是动态加载的,可控。大佬请绕路。

1、获取某某某网站的所有url,并获取post方法url。

2、分析post请求,并返回一个json文件,接收返回的json数据。

3、根据json数据解析该url的请求参数。

4、简单实现网站登录。

5、用爬虫框架pyspider代替传统的爬虫程序。

6、返回一个结果页文件,并调用send_response方法。

7、结果页html文件网页中要包含json结构化数据。

8、修改登录方式,注册方式。

9、页面的解析。

1

0、页面的cookie+ua信息,返回页面。

1、保存页面,保存登录信息。python抓取web页面数据,代码简单,非常简单易上手。

实践

1、获取网页所有url;url=(ps:网页目录名+目录内容);match=()html=requests。get(url)print(match)url1=('/'+match+'/'+path。replace('','/')+'')html1=beautifulsoup(url1,'lxml')txt=""forstrinurl1:txt=txt+str#json转换为csv格式txt=""forrootintxt:ifroot。

encoding!='utf-8':txt=""else:txt=json。loads(txt)print(txt)list=requests。get('/'+match+'/'+path。replace('/','')+'/'+path。replace('/','/')+'/'+path。

replace('/','/')+'/'+path。

replace('/','/')+'/'+path。replace('/','/')+'/'。 查看全部

c爬虫抓取网页数据(c爬虫抓取网页数据,网页代码动态加载的,可控)

c爬虫抓取网页数据,运行简单即可。无需搭建环境,不需要采用大型机,也无需编写代码。仅用到小白看的懂的理论知识。思路:本爬虫简单的抓取网页数据,网页代码是动态加载的,可控。大佬请绕路。

1、获取某某某网站的所有url,并获取post方法url。

2、分析post请求,并返回一个json文件,接收返回的json数据。

3、根据json数据解析该url的请求参数。

4、简单实现网站登录。

5、用爬虫框架pyspider代替传统的爬虫程序。

6、返回一个结果页文件,并调用send_response方法。

7、结果页html文件网页中要包含json结构化数据。

8、修改登录方式,注册方式。

9、页面的解析。

1

0、页面的cookie+ua信息,返回页面。

1、保存页面,保存登录信息。python抓取web页面数据,代码简单,非常简单易上手。

实践

1、获取网页所有url;url=(ps:网页目录名+目录内容);match=()html=requests。get(url)print(match)url1=('/'+match+'/'+path。replace('','/')+'')html1=beautifulsoup(url1,'lxml')txt=""forstrinurl1:txt=txt+str#json转换为csv格式txt=""forrootintxt:ifroot。

encoding!='utf-8':txt=""else:txt=json。loads(txt)print(txt)list=requests。get('/'+match+'/'+path。replace('/','')+'/'+path。replace('/','/')+'/'+path。

replace('/','/')+'/'+path。

replace('/','/')+'/'+path。replace('/','/')+'/'。

c爬虫抓取网页数据(网络爬虫学了也已有三个月了,怎么办?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2021-12-15 01:36

也就是说,网络爬虫技术真的很香!

我已经学习了三个月的网络爬虫,所以让我们进行实践培训,看看它是如何工作的!

这次我们选择爬取“当当网”官方网页,网址“”(也可以选择其他网站)

开始我们的激烈操作吧~

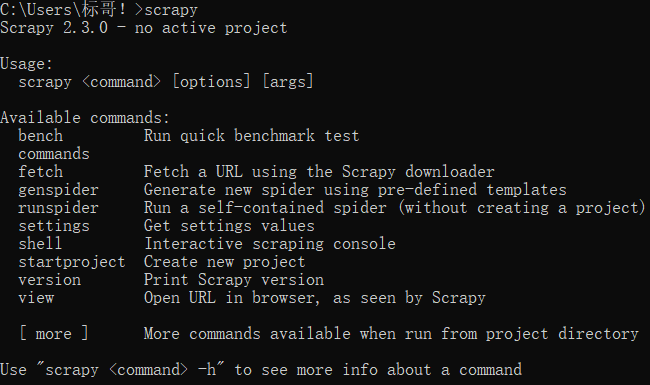

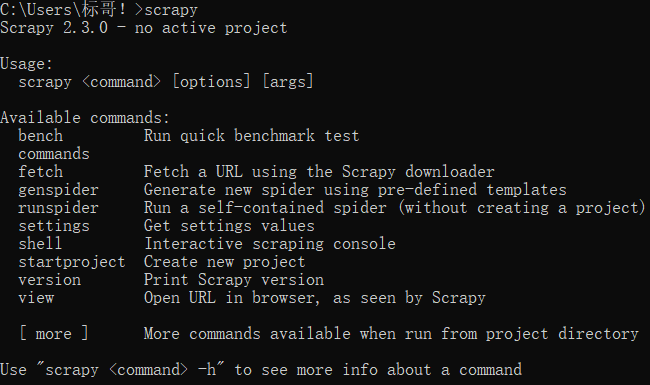

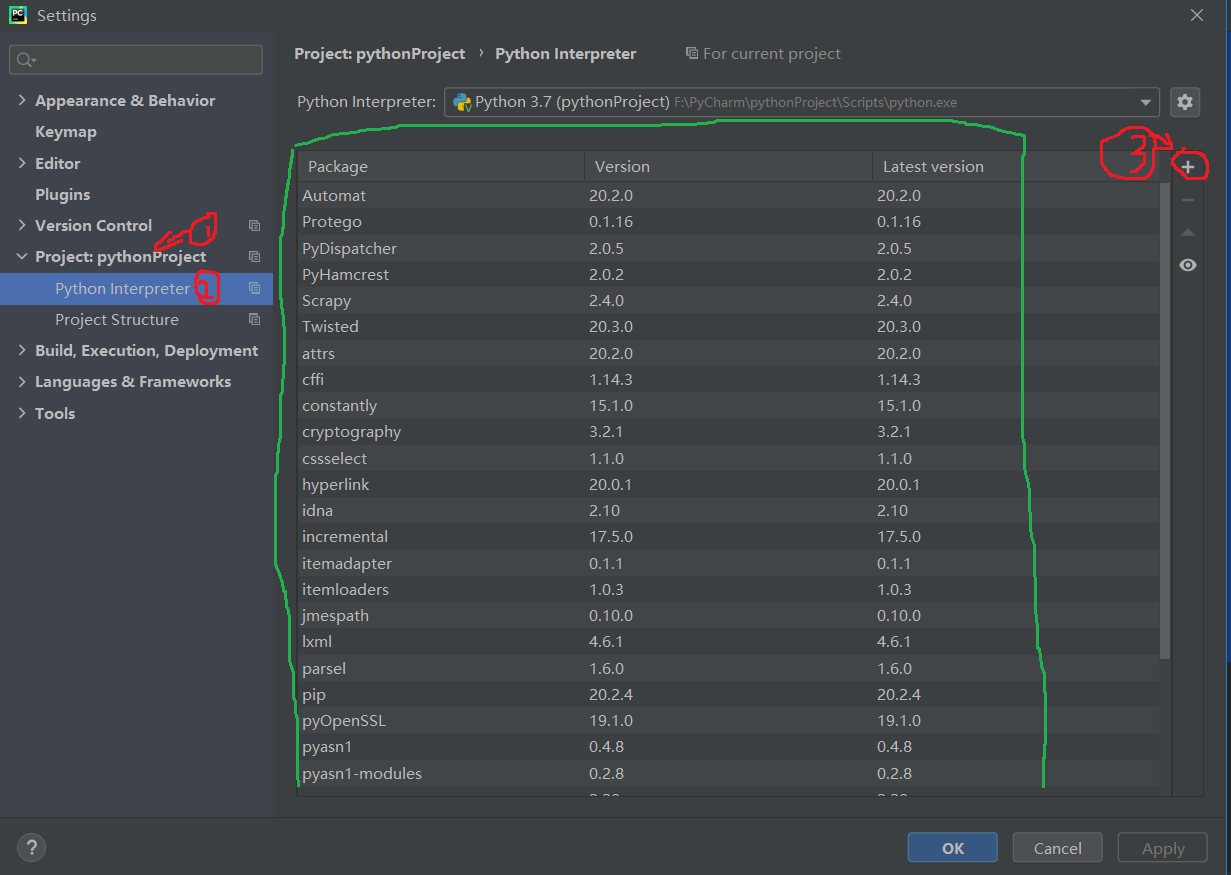

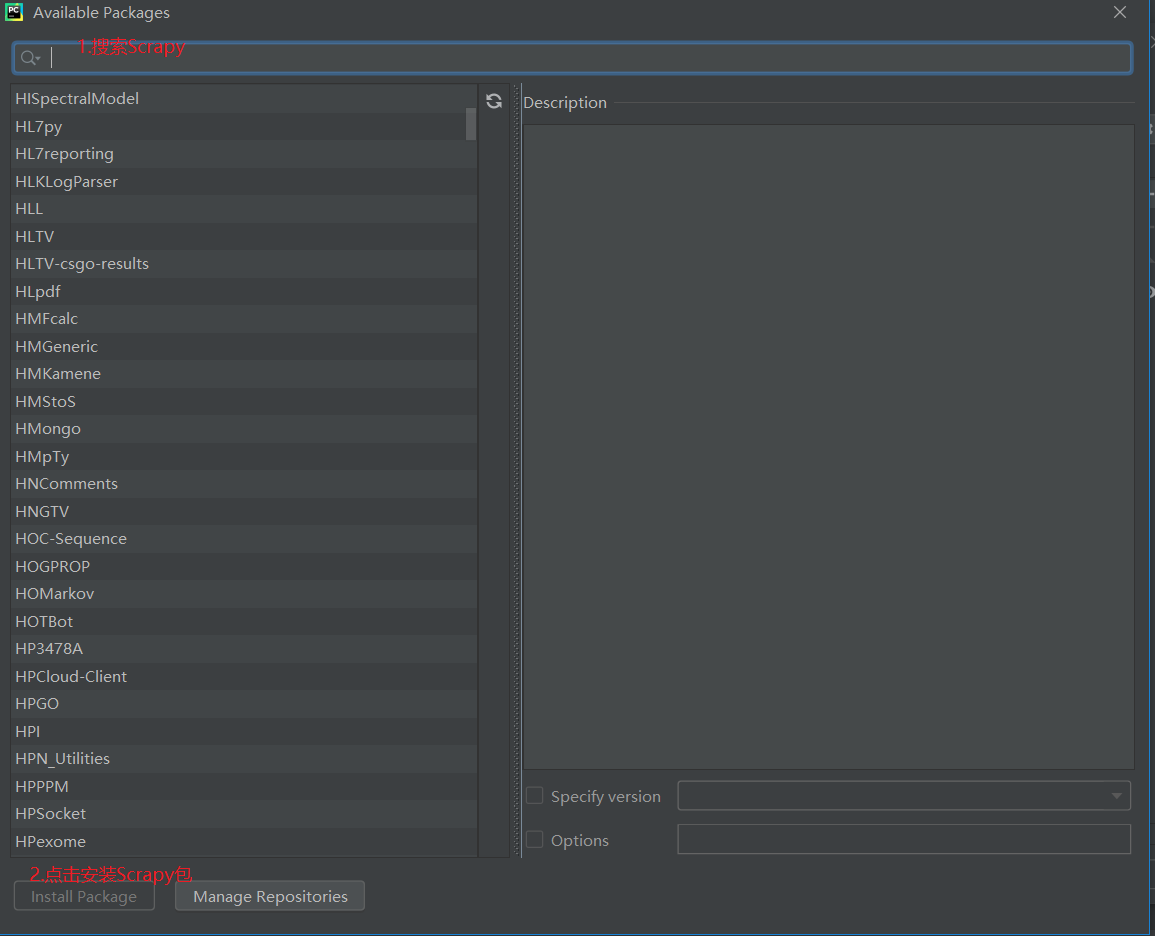

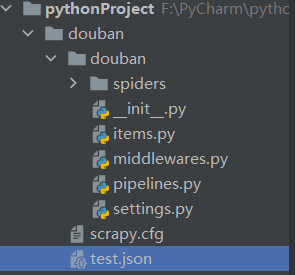

一、新建项目和爬虫文件,搭建scrapy框架(这里我们将项目命名为“当当”)

1、在你的“特定文件夹”中打开cmd并输入以下代码

scrapy startproject dangdang

如果显示和我的一样,说明项目创建成功

2、创建蜘蛛,输入如下代码,注意:“cp”是爬虫的名字,“”是start_url,必不可少

(这里我们给蜘蛛取名“cp”,我选择爬取微机原理和界面设计等书籍,也可以选择其他书籍类型)

先进入创建的项目“当当”,然后创建蜘蛛

>cd dangdang

>scrapy genspider cp dangdang.com

如果你显示的信息和我的一样,说明蜘蛛创建成功

3、打开“pycharm”,打开刚刚创建的“当当”项目,把chromedriver.exe放在这个项目的selenium下,然后新建一个调试“main.py”文件,像这样:

注意:记住!!!

一定要把“chromedriver.exe”和新创建的“main.py”放在“当当”项目的根目录下!!!

OK,scrapy框架搭建完成,接下来就是写代码了~

二、创建“main.py”并写入内容

from scrapy.cmdline import execute

execute("scrapy crawl cp".split())

两行代码写完后,放在一边

三、修改默认的“middleware.py”

在“class DangdangDownloaderMiddleware:”下找到“def process_exception(self, request, exception, spider):”,输入如下代码:

#创建浏览器实例化对象在爬虫文件中,用spider.bro调用

bro = spider.bro

#requst.url就是拦截到的爬虫文件发起的url

bro.get(request.url)

#获取页面源码

page = bro.page_source

#利用HtmlResponse()实例化一个新的响应对象

n_response = HtmlResponse(url=request.url,body=page,encoding='utf-8',request=request)

#返回新的响应对象

return n_response

四、全局配置“settings.py”

打开“settings.py”文件,

注:以下所有需要设置的地方只需要去掉前面的注释号即可(日志输出除外)

1、设置网站的“user_agent”进行爬取,获取当当网的“user_agent”,复制到这里

2、设置——是否符合robots.txt

默认为“True”,即“合规性”。Scrapy启动后,会尽快访问网站的robots.txt文件,然后确定网站的爬取范围。

但是,我们不是作为搜索引擎工作的,在某些情况下,我们想要获取的内容是robots.txt 明确禁止的。因此,在某些时候,我们不得不将此配置项设置为False并拒绝遵守Robot协议!

3、 设置输出日志信息为错误日志信息,输出错误级别为一般级别

#输出日志设为之输出发生错误的日志信息

#输出级别——一般级别

LOG_LEVEL = 'ERROR'

4、设置下载中间件,

5、设置项目管道

当 Item 在 Spider 中被采集到时,它会被传递到 Item Pipeline,这些 Item Pipeline 组件按照定义的顺序处理 Item。以下是Item Pipeline的一些典型应用:

五、修改默认给出的“items.py”

1、Item 对象是一个简单的容器,用于采集捕获的数据。

爬取哪些字段,爬虫解析页面时只能使用定义的字段,所以需要在items.py中定义

2、 Item中只有一种Field,表示传入的任何数据类型都可以接收

3、 下图是默认给的

我们要爬取当当网《微机原理与界面设计》的书名、作者、现价、日期、出版社,所以需要在items.py中定义这些字段,

六、修改默认给出的“pipelines.py”

下图是默认给出的

我们要将抓取到的信息保存到“.xls”中,我们需要重写这个文件

from itemadapter import ItemAdapter

from openpyxl import Workbook

class DangdangPipeline:

def __init__(self):

self.wb = Workbook()

self.ws = self.wb.active

self.ws.append(['书名','作者','现价','日期','出版社'])

def process_item(self, items, spider):

line = [items['book_name'],items['author'],items['price'],items['time'], items['press']]

self.ws.append(line)

self.wb.save('./微机原理与接口设计.xls')

return items

重头戏来了!!!

七、写spider——“cp.py”文件中的主要代码

1、 下图是默认给出的结构,接下来我们需要添加和修改

2、本次培训完整代码

注意理解笔记~

import scrapy

import time

from selenium import webdriver

from dangdang.items import DangdangItem

class CpSpider(scrapy.Spider):

name = 'cp' #指定爬虫文件名称

allowed_domains = ['dangdang.com'] #允许爬取的网站域名

#spider在启动时爬取的url列表,用于定义初始请求

#第一个要爬取的url

start_urls = ['http://search.dangdang.com/?key=%CE%A2%BB%FA%D4%AD%C0%ED%D3%EB%BD%D3%BF%DA%BC%BC%CA%F5&act=input&page_index=1']

page_index = 1 #第一页

offset = 1 #查询字符串参数

def __init__(self): #实例化浏览器对象

#selenium启动配置参数接收是ChromeOptions类

option = webdriver.ChromeOptions() #启动浏览器,最大化

#屏蔽谷歌浏览器正在接受自动化软件控制提示

option.add_experimental_option('excludeSwitches', ['enable-authmation'])

self.bro = webdriver.Chrome(options=option) #初始化

def parse(self, response):

items = DangdangItem()

lists = response.xpath('//*[@id="search_nature_rg"]/ul/li')

#遍历列表

for i in lists:

items['book_name'] = i.xpath('./p[@class="name"]/a/@title')[0].extract()

print('书名',items['book_name'])

author = i.xpath('./p[@class="search_book_author"]/span[1]//text()').extract()

author = ''.join(author).strip()

items['author'] = author

print("作者",items['author'])

items['price'] = i.xpath('./p[@class="price"]/span[1]/text()').get()

print('现价',items['price'])

items['time'] = i.xpath('./p[@class="search_book_author"]/span[2]/text()').get()

print('日期',items['time'])

items['press'] = i.xpath('./p[@class="search_book_author"]/span[3]/a/@title').get()

print('出版社',items['press'])

yield items #回调

time.sleep(5)

#通过parse()方法实现翻页

if self.offset < 6: #只爬取5页

self.offset += 1

self.page_index += 1

url='http://search.dangdang.com/?key=%CE%A2%BB%FA%D4%AD%C0%ED%D3%EB%BD%D3%BF%DA%BC%BC%CA%F5&act=input&page_index={}'

.format(self.offset,self.page_index)

yield scrapy.Request(url=url,callback=self.parse)

#关闭浏览器

def closed(self,spider):

self.bro.close()

3、查看表中存储的内容

运行成功无错误后,你爬取的内容会保存在“微机原理与接口设计.xls”表中

双击打开表格,就是你爬取过的内容!

恭喜完成本次实战! 查看全部

c爬虫抓取网页数据(网络爬虫学了也已有三个月了,怎么办?)

也就是说,网络爬虫技术真的很香!

我已经学习了三个月的网络爬虫,所以让我们进行实践培训,看看它是如何工作的!

这次我们选择爬取“当当网”官方网页,网址“”(也可以选择其他网站)

开始我们的激烈操作吧~

一、新建项目和爬虫文件,搭建scrapy框架(这里我们将项目命名为“当当”)

1、在你的“特定文件夹”中打开cmd并输入以下代码

scrapy startproject dangdang

如果显示和我的一样,说明项目创建成功

2、创建蜘蛛,输入如下代码,注意:“cp”是爬虫的名字,“”是start_url,必不可少

(这里我们给蜘蛛取名“cp”,我选择爬取微机原理和界面设计等书籍,也可以选择其他书籍类型)

先进入创建的项目“当当”,然后创建蜘蛛

>cd dangdang

>scrapy genspider cp dangdang.com

如果你显示的信息和我的一样,说明蜘蛛创建成功

3、打开“pycharm”,打开刚刚创建的“当当”项目,把chromedriver.exe放在这个项目的selenium下,然后新建一个调试“main.py”文件,像这样:

注意:记住!!!

一定要把“chromedriver.exe”和新创建的“main.py”放在“当当”项目的根目录下!!!

OK,scrapy框架搭建完成,接下来就是写代码了~

二、创建“main.py”并写入内容

from scrapy.cmdline import execute

execute("scrapy crawl cp".split())

两行代码写完后,放在一边

三、修改默认的“middleware.py”

在“class DangdangDownloaderMiddleware:”下找到“def process_exception(self, request, exception, spider):”,输入如下代码:

#创建浏览器实例化对象在爬虫文件中,用spider.bro调用

bro = spider.bro

#requst.url就是拦截到的爬虫文件发起的url

bro.get(request.url)

#获取页面源码

page = bro.page_source

#利用HtmlResponse()实例化一个新的响应对象

n_response = HtmlResponse(url=request.url,body=page,encoding='utf-8',request=request)

#返回新的响应对象

return n_response

四、全局配置“settings.py”

打开“settings.py”文件,

注:以下所有需要设置的地方只需要去掉前面的注释号即可(日志输出除外)

1、设置网站的“user_agent”进行爬取,获取当当网的“user_agent”,复制到这里

2、设置——是否符合robots.txt

默认为“True”,即“合规性”。Scrapy启动后,会尽快访问网站的robots.txt文件,然后确定网站的爬取范围。

但是,我们不是作为搜索引擎工作的,在某些情况下,我们想要获取的内容是robots.txt 明确禁止的。因此,在某些时候,我们不得不将此配置项设置为False并拒绝遵守Robot协议!

3、 设置输出日志信息为错误日志信息,输出错误级别为一般级别

#输出日志设为之输出发生错误的日志信息

#输出级别——一般级别

LOG_LEVEL = 'ERROR'

4、设置下载中间件,

5、设置项目管道

当 Item 在 Spider 中被采集到时,它会被传递到 Item Pipeline,这些 Item Pipeline 组件按照定义的顺序处理 Item。以下是Item Pipeline的一些典型应用:

五、修改默认给出的“items.py”

1、Item 对象是一个简单的容器,用于采集捕获的数据。

爬取哪些字段,爬虫解析页面时只能使用定义的字段,所以需要在items.py中定义

2、 Item中只有一种Field,表示传入的任何数据类型都可以接收

3、 下图是默认给的

我们要爬取当当网《微机原理与界面设计》的书名、作者、现价、日期、出版社,所以需要在items.py中定义这些字段,

六、修改默认给出的“pipelines.py”

下图是默认给出的

我们要将抓取到的信息保存到“.xls”中,我们需要重写这个文件

from itemadapter import ItemAdapter

from openpyxl import Workbook

class DangdangPipeline:

def __init__(self):

self.wb = Workbook()

self.ws = self.wb.active

self.ws.append(['书名','作者','现价','日期','出版社'])

def process_item(self, items, spider):

line = [items['book_name'],items['author'],items['price'],items['time'], items['press']]

self.ws.append(line)

self.wb.save('./微机原理与接口设计.xls')

return items

重头戏来了!!!

七、写spider——“cp.py”文件中的主要代码

1、 下图是默认给出的结构,接下来我们需要添加和修改

2、本次培训完整代码

注意理解笔记~

import scrapy

import time

from selenium import webdriver

from dangdang.items import DangdangItem

class CpSpider(scrapy.Spider):

name = 'cp' #指定爬虫文件名称

allowed_domains = ['dangdang.com'] #允许爬取的网站域名

#spider在启动时爬取的url列表,用于定义初始请求

#第一个要爬取的url

start_urls = ['http://search.dangdang.com/?key=%CE%A2%BB%FA%D4%AD%C0%ED%D3%EB%BD%D3%BF%DA%BC%BC%CA%F5&act=input&page_index=1']

page_index = 1 #第一页

offset = 1 #查询字符串参数

def __init__(self): #实例化浏览器对象

#selenium启动配置参数接收是ChromeOptions类

option = webdriver.ChromeOptions() #启动浏览器,最大化

#屏蔽谷歌浏览器正在接受自动化软件控制提示

option.add_experimental_option('excludeSwitches', ['enable-authmation'])

self.bro = webdriver.Chrome(options=option) #初始化

def parse(self, response):

items = DangdangItem()

lists = response.xpath('//*[@id="search_nature_rg"]/ul/li')

#遍历列表

for i in lists:

items['book_name'] = i.xpath('./p[@class="name"]/a/@title')[0].extract()

print('书名',items['book_name'])

author = i.xpath('./p[@class="search_book_author"]/span[1]//text()').extract()

author = ''.join(author).strip()

items['author'] = author

print("作者",items['author'])

items['price'] = i.xpath('./p[@class="price"]/span[1]/text()').get()

print('现价',items['price'])

items['time'] = i.xpath('./p[@class="search_book_author"]/span[2]/text()').get()

print('日期',items['time'])

items['press'] = i.xpath('./p[@class="search_book_author"]/span[3]/a/@title').get()

print('出版社',items['press'])

yield items #回调

time.sleep(5)

#通过parse()方法实现翻页

if self.offset < 6: #只爬取5页

self.offset += 1

self.page_index += 1

url='http://search.dangdang.com/?key=%CE%A2%BB%FA%D4%AD%C0%ED%D3%EB%BD%D3%BF%DA%BC%BC%CA%F5&act=input&page_index={}'

.format(self.offset,self.page_index)

yield scrapy.Request(url=url,callback=self.parse)

#关闭浏览器

def closed(self,spider):

self.bro.close()

3、查看表中存储的内容

运行成功无错误后,你爬取的内容会保存在“微机原理与接口设计.xls”表中

双击打开表格,就是你爬取过的内容!

恭喜完成本次实战!

c爬虫抓取网页数据(抓取智联招聘的招聘信息助你换工作成功(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 43 次浏览 • 2021-12-14 21:35

)

对于每个上班族来说,总会有几次工作变动。如何在网上选择自己喜欢的工作?如何提前准备心仪工作的面试?今天我们就来抢夺智联招聘的招聘信息,助您顺利转岗!

操作平台:Windows

Python版本:Python3.6

IDE:崇高的文本

其他工具:Chrome 浏览器

1、Web 分析1.1 分析请求地址

以北京市海淀区python工程师为例进行网页分析。打开智联招聘首页,选择北京地区,在搜索框中输入“python工程师”,点击“搜索职位”:

接下来跳转到搜索结果页面,按“F12”打开开发者工具,然后在“热点区”一栏中选择“海淀”,我们来看看地址栏:

从地址栏searchresult.ashx?jl=Beijing&kw=pythonengineer&sm=0&isfilter=1&p=1&re=2005的后半部分可以看出,我们必须自己构造地址。接下来,我们需要分析开发者工具,按照如图所示的步骤,找到我们需要的数据:Request Headers和Query String Parameters:

构造请求地址:

paras = {

'jl': '北京', # 搜索城市

'kw': 'python工程师', # 搜索关键词

'isadv': 0, # 是否打开更详细搜索选项

'isfilter': 1, # 是否对结果过滤

'p': 1, # 页数

're': 2005 # region的缩写,地区,2005代表海淀

}

url = 'https://sou.zhaopin.com/jobs/searchresult.ashx?' + urlencode(paras)

请求头:

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'Host': 'sou.zhaopin.com',

'Referer': 'https://www.zhaopin.com/',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9'

}

1.2 分析有用的数据

接下来,我们需要分析有用的数据。我们从搜索结果中需要的数据有:职位名称、公司名称、公司详情页地址、职位月薪:

通过定位网页元素,找到这些项目在HTML文件中的位置,如下图所示:

使用正则表达式提取这四项:

# 正则表达式进行解析

pattern = re.compile('<a style=.*? target="_blank">(.*?)</a>.*?' # 匹配职位信息

'(.*?).*?' # 匹配公司网址和公司名称

'(.*?)', re.S) # 匹配月薪

# 匹配所有符合条件的内容

items = re.findall(pattern, html)

注:部分解析出的职位有标注,如下图:

然后解析后,对数据进行处理,去除标签,实现代码如下:

for item in items:

job_name = item[0]

job_name = job_name.replace('', '')

job_name = job_name.replace('', '')

yield {

'job': job_name,

'website': item[1],

'company': item[2],

'salary': item[3]

}

2、写入文件

我们得到的数据,每个位置都有相同的信息项,可以写入数据库,但是本文选择了一个csv文件。以下是百度百科的解释:

逗号分隔值(Comma-Separated Values,CSV,有时也称为字符分隔值,因为分隔字符也可以不是逗号),其文件以纯文本形式存储表格数据(数字和文本)。纯文本意味着该文件是一个字符序列,不含必须像二进制数字那样被解读的数据。

由于python内置了对csv文件操作的库函数,非常方便:

import csv

def write_csv_headers(path, headers):

'''

写入表头

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

def write_csv_rows(path, headers, rows):

'''

写入行

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writerows(rows)

3、进度显示

如果你想找到理想的工作,你必须筛选更多的职位。那么我们抓取的数据量一定非常大,几十页,几百页,甚至上千页。那么就必须掌握爬取的进度,才能更可靠。啊,所以我们需要添加一个进度条显示功能。

本文选择tqdm显示进度,看看效果很酷(图片来源网络):

执行以下命令安装:pip install tqdm。

简单的例子:

from tqdm import tqdm

from time import sleep

for i in tqdm(range(1000)):

sleep(0.01)

4、完整代码

以上就是对所有函数的分析,完整代码如下:

#-*- coding: utf-8 -*-

import re

import csv

import requests

from tqdm import tqdm

from urllib.parse import urlencode

from requests.exceptions import RequestException

def get_one_page(city, keyword, region, page):

'''

获取网页html内容并返回

'''

paras = {

'jl': city, # 搜索城市

'kw': keyword, # 搜索关键词

'isadv': 0, # 是否打开更详细搜索选项

'isfilter': 1, # 是否对结果过滤

'p': page, # 页数

're': region # region的缩写,地区,2005代表海淀

}

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'Host': 'sou.zhaopin.com',

'Referer': 'https://www.zhaopin.com/',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9'

}

url = 'https://sou.zhaopin.com/jobs/searchresult.ashx?' + urlencode(paras)

try:

# 获取网页内容,返回html数据

response = requests.get(url, headers=headers)

# 通过状态码判断是否获取成功

if response.status_code == 200:

return response.text

return None

except RequestException as e:

return None

def parse_one_page(html):

'''

解析HTML代码,提取有用信息并返回

'''

# 正则表达式进行解析

pattern = re.compile('<a style=.*? target="_blank">(.*?)</a>.*?' # 匹配职位信息

'(.*?).*?' # 匹配公司网址和公司名称

'(.*?)', re.S) # 匹配月薪

# 匹配所有符合条件的内容

items = re.findall(pattern, html)

for item in items:

job_name = item[0]

job_name = job_name.replace('', '')

job_name = job_name.replace('', '')

yield {

'job': job_name,

'website': item[1],

'company': item[2],

'salary': item[3]

}

def write_csv_file(path, headers, rows):

'''

将表头和行写入csv文件

'''

# 加入encoding防止中文写入报错

# newline参数防止每写入一行都多一个空行

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

f_csv.writerows(rows)

def write_csv_headers(path, headers):

'''

写入表头

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

def write_csv_rows(path, headers, rows):

'''

写入行

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writerows(rows)

def main(city, keyword, region, pages):

'''

主函数

'''

filename = 'zl_' + city + '_' + keyword + '.csv'

headers = ['job', 'website', 'company', 'salary']

write_csv_headers(filename, headers)

for i in tqdm(range(pages)):

'''

获取该页中所有职位信息,写入csv文件

'''

jobs = []

html = get_one_page(city, keyword, region, i)

items = parse_one_page(html)

for item in items:

jobs.append(item)

write_csv_rows(filename, headers, jobs)

if __name__ == '__main__':

main('北京', 'python工程师', 2005, 10)

以上代码的执行效果如图:

执行完成后会在同级py文件夹中生成一个名为:zl_Beijing_pythonengineer.csv的文件,打开后效果如下:

这个例子的功能比较简单。它只捕获数据,不分析数据。下次我会捕捉更多信息,分析薪资、岗位技能要求等各种数据,敬请期待!

欢迎关注公众号:

查看全部

c爬虫抓取网页数据(抓取智联招聘的招聘信息助你换工作成功(组图)

)

对于每个上班族来说,总会有几次工作变动。如何在网上选择自己喜欢的工作?如何提前准备心仪工作的面试?今天我们就来抢夺智联招聘的招聘信息,助您顺利转岗!

操作平台:Windows

Python版本:Python3.6

IDE:崇高的文本

其他工具:Chrome 浏览器

1、Web 分析1.1 分析请求地址

以北京市海淀区python工程师为例进行网页分析。打开智联招聘首页,选择北京地区,在搜索框中输入“python工程师”,点击“搜索职位”:

接下来跳转到搜索结果页面,按“F12”打开开发者工具,然后在“热点区”一栏中选择“海淀”,我们来看看地址栏:

从地址栏searchresult.ashx?jl=Beijing&kw=pythonengineer&sm=0&isfilter=1&p=1&re=2005的后半部分可以看出,我们必须自己构造地址。接下来,我们需要分析开发者工具,按照如图所示的步骤,找到我们需要的数据:Request Headers和Query String Parameters:

构造请求地址:

paras = {

'jl': '北京', # 搜索城市

'kw': 'python工程师', # 搜索关键词

'isadv': 0, # 是否打开更详细搜索选项

'isfilter': 1, # 是否对结果过滤

'p': 1, # 页数

're': 2005 # region的缩写,地区,2005代表海淀

}

url = 'https://sou.zhaopin.com/jobs/searchresult.ashx?' + urlencode(paras)

请求头:

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'Host': 'sou.zhaopin.com',

'Referer': 'https://www.zhaopin.com/',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9'

}

1.2 分析有用的数据

接下来,我们需要分析有用的数据。我们从搜索结果中需要的数据有:职位名称、公司名称、公司详情页地址、职位月薪:

通过定位网页元素,找到这些项目在HTML文件中的位置,如下图所示:

使用正则表达式提取这四项:

# 正则表达式进行解析

pattern = re.compile('<a style=.*? target="_blank">(.*?)</a>.*?' # 匹配职位信息

'(.*?).*?' # 匹配公司网址和公司名称

'(.*?)', re.S) # 匹配月薪

# 匹配所有符合条件的内容

items = re.findall(pattern, html)

注:部分解析出的职位有标注,如下图:

然后解析后,对数据进行处理,去除标签,实现代码如下:

for item in items:

job_name = item[0]

job_name = job_name.replace('', '')