c爬虫抓取网页数据

c爬虫抓取网页数据(c爬虫中存储的数据全部存储到collection中的格式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2021-12-06 09:10

c爬虫抓取网页数据。pyhttp协议爬虫。py爬虫脚本。neo4j、reshack库。设计多爬虫。cms、mongodb、。解释defscrapy_jiang_generator(spider):fromcollectionsimportcollectioncollection=collection("spider")withcollection。

items()asspider:spider。page(spider。spiderurl())爬虫中存储的数据全部存储到collection中,不建议通过scrapy获取。存储到collection中的数据格式,建议是json,raw,但个人更推荐使用xml格式存储。例如echart。json和xml2。

generator里有个重载scrapy_spider_update()方法,它会像人的大脑一样,不断的更新网页上的spider。collection中的数据。scrapy_spider_update()可以让网页上的spider,获取并存储最新的信息。windows安装export/calcitemysql安装export/calcitepython安装安装calcitepython代码1。

importscrapy2。classspider(scrapy。spider):3。item=scrapy。field()4。field_list=["user_id","password"]5。items=spider。items()6。fields=["user_id","password"]7。

spider=spider(callback=spider。callback)8。spider。page()9。collection=collection("spider")10。fields=['user_id','password']spider=spider(callback=spider。callback)11。

fields=['user_id','password']12。caspider=caspider(callback=spider。callback)13。caspider。start()14。close()15。python代码获取所有的spider源码分享站:;wxpython。 查看全部

c爬虫抓取网页数据(c爬虫中存储的数据全部存储到collection中的格式)

c爬虫抓取网页数据。pyhttp协议爬虫。py爬虫脚本。neo4j、reshack库。设计多爬虫。cms、mongodb、。解释defscrapy_jiang_generator(spider):fromcollectionsimportcollectioncollection=collection("spider")withcollection。

items()asspider:spider。page(spider。spiderurl())爬虫中存储的数据全部存储到collection中,不建议通过scrapy获取。存储到collection中的数据格式,建议是json,raw,但个人更推荐使用xml格式存储。例如echart。json和xml2。

generator里有个重载scrapy_spider_update()方法,它会像人的大脑一样,不断的更新网页上的spider。collection中的数据。scrapy_spider_update()可以让网页上的spider,获取并存储最新的信息。windows安装export/calcitemysql安装export/calcitepython安装安装calcitepython代码1。

importscrapy2。classspider(scrapy。spider):3。item=scrapy。field()4。field_list=["user_id","password"]5。items=spider。items()6。fields=["user_id","password"]7。

spider=spider(callback=spider。callback)8。spider。page()9。collection=collection("spider")10。fields=['user_id','password']spider=spider(callback=spider。callback)11。

fields=['user_id','password']12。caspider=caspider(callback=spider。callback)13。caspider。start()14。close()15。python代码获取所有的spider源码分享站:;wxpython。

c爬虫抓取网页数据(《Python3网络爬虫实战》本书共分11章盘链接)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-12-05 13:00

随着大数据分析和大数据计算的兴起,越来越多的公司发布了数据分析职位,而数据分析的基础是海量数据。Python 中的爬虫框架旨在爬取数据。

Python简单易学,Python爬虫并不复杂。你只需要了解Python的基本操作就可以自己编写了。对于互联网上更新频繁的数据,无需每次都打开网页。您可以使用爬虫一键获取数据,下载并保存数据进行数据分析。不同类型的 Python 爬虫可以采集不同站点的数据。

《Python 3 网络爬虫实战》

本书从Python3.8的安装开始,详细讲解了从基础网页到Python网络爬虫的全过程。本书从实战出发,根据不同的需求选择不同的网络爬虫,有针对性地讲解了几种Python网络爬虫。

本书共12章,内容涵盖网络爬虫的技术基础、Python常用IDE的使用、Python数据的存储、Python爬虫模块、Scrapy爬虫、BeautifulSoup爬虫、PyQuery模块、Selenium模拟浏览器、PySpider帧图像验证识别和抓取应用程序、爬虫和反爬虫等。

本书内容丰富,实例典型,实用性强。适合Python网络爬虫初学者、Python数据分析挖掘技术初学者,以及大中专院校师生阅读。

《Scrapy Web Crawler实战》

本书分为11章。第1~2章介绍了Python环境的搭建、编辑器的使用、爬虫的一些基础知识(urllib、requests、Selenium、Xpath、CSS、正则表达式、BeautifulSoup库)等。第3~8章主要介绍原理和 Scrapy 框架的使用。第9~11章主要介绍了Scrapy的优化,包括内置服务、组件优化等,最后用一个完整的大规模实例总结全书知识点。

这两本书的配套示例源码可以从以下百度网盘链接下载,供读者个人学习使用,禁止任何形式的商业用途。

提取码:6m3d

《Python 3.7 网络爬虫快速入门》

全书共分11章,分别介绍了Python3.7爬虫开发基础知识、lxml模块、正则表达式、文件处理、多线程爬虫、图形识别、Scrapy框架、PyQuery模块等。基本上每章都配有很多小示例程序和一个大的实际案例。作者还为每一章录制了教学视频,供读者自学参考。 查看全部

c爬虫抓取网页数据(《Python3网络爬虫实战》本书共分11章盘链接)

随着大数据分析和大数据计算的兴起,越来越多的公司发布了数据分析职位,而数据分析的基础是海量数据。Python 中的爬虫框架旨在爬取数据。

Python简单易学,Python爬虫并不复杂。你只需要了解Python的基本操作就可以自己编写了。对于互联网上更新频繁的数据,无需每次都打开网页。您可以使用爬虫一键获取数据,下载并保存数据进行数据分析。不同类型的 Python 爬虫可以采集不同站点的数据。

《Python 3 网络爬虫实战》

本书从Python3.8的安装开始,详细讲解了从基础网页到Python网络爬虫的全过程。本书从实战出发,根据不同的需求选择不同的网络爬虫,有针对性地讲解了几种Python网络爬虫。

本书共12章,内容涵盖网络爬虫的技术基础、Python常用IDE的使用、Python数据的存储、Python爬虫模块、Scrapy爬虫、BeautifulSoup爬虫、PyQuery模块、Selenium模拟浏览器、PySpider帧图像验证识别和抓取应用程序、爬虫和反爬虫等。

本书内容丰富,实例典型,实用性强。适合Python网络爬虫初学者、Python数据分析挖掘技术初学者,以及大中专院校师生阅读。

《Scrapy Web Crawler实战》

本书分为11章。第1~2章介绍了Python环境的搭建、编辑器的使用、爬虫的一些基础知识(urllib、requests、Selenium、Xpath、CSS、正则表达式、BeautifulSoup库)等。第3~8章主要介绍原理和 Scrapy 框架的使用。第9~11章主要介绍了Scrapy的优化,包括内置服务、组件优化等,最后用一个完整的大规模实例总结全书知识点。

这两本书的配套示例源码可以从以下百度网盘链接下载,供读者个人学习使用,禁止任何形式的商业用途。

提取码:6m3d

《Python 3.7 网络爬虫快速入门》

全书共分11章,分别介绍了Python3.7爬虫开发基础知识、lxml模块、正则表达式、文件处理、多线程爬虫、图形识别、Scrapy框架、PyQuery模块等。基本上每章都配有很多小示例程序和一个大的实际案例。作者还为每一章录制了教学视频,供读者自学参考。

c爬虫抓取网页数据(网络爬虫的基本工作流程:1.的发展基本流程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-12-05 09:02

下面是一个很有启发的文章先分享给大家。

信息论的发展

通过上一篇我们了解了爬虫的具体工作后,我们分析的网络爬虫的基本工作流程如下:

1.首先选择一些精心挑选的种子网址;

2.将这些URL放入URL队列进行抓取;

3. 从待爬取的URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,并存入下载的网页库中。另外,将这些网址放入已爬取的网址队列中。

4.对爬取的URL队列中的URL进行分析,分析其中的其他URL,将这些URL放入URL队列进行爬取,从而进入下一个循环。

一、爬虫设计

从爬虫的角度来划分互联网,互联网的所有页面可以分为五个部分:

1.下载了未过期的网页

2.已下载并过期的网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态变化的,互联网上的部分内容已经发生了变化。此时,这部分爬取到的页面已经过期。

3.要下载的页面:URL队列中要爬取的那些页面

4. 已知网页:尚未被抓取,也不在待抓取的 URL 队列中,但通过分析抓取的页面或待抓取的 URL 对应的页面得到的 URL,被认为是一个已知网页。

5. 还有一些网页是爬虫无法直接抓取下载的。它被称为不可知页面。

我们爬虫项目的主要事件流程大致如下:

1.获取命令行参数并进行相应操作

2. 读取配置文件,解析各种设置

3.加载各种模块

4. 种子入队,启动DNS解析线程(原队列不为空时解析)

5.创建epoll,启动任务,发起请求等,关注事件

6.在while循环中,使用epoll_wait返回active事件,每个事件启动一个线程处理(线程主要解析页面,保存页面,url处理等),可能在开始一个新的任务线程的结尾。(或者在程序初始化的时候创建一个线程池,没有任务的时候阻塞线程,通过pthread_cond_signal唤醒睡眠队列中的线程,但是一个页面解析出来的有效url会很多。这个时候,我们甚至需要在队列满时阻塞分析页面url线程,使用线程池的好处是减少线程创建和销毁的系统开销)

在爬虫系统中,要爬取的URL队列是一个非常重要的部分。URL队列中要爬取的URL按什么顺序排列也是一个很重要的问题,因为它涉及到先爬哪个页面,后爬哪个页面。确定这些 URL 顺序的方法称为抓取策略。下面重点介绍几种常见的爬取策略(关于爬取策略优劣分析的建议,请阅读吴军老师《数学之美》第9章和第10章):

1.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,逐个跟踪每一个链接,处理完这一行后转移到下一个起始页,继续跟踪链接。

2.广度优先遍历策略

广度优先遍历策略的基本思想是将新下载的网页中找到的链接直接插入到待爬取的URL队列的末尾。即网络爬虫会先抓取起始网页中所有链接的网页,然后选择其中一个链接的网页,继续抓取该网页中链接的所有网页。以上图为例:

3.反向链接计数策略

反向链接数是指从其他网页链接到某个网页的数量。反向链接的数量表示网页内容被他人推荐的程度。因此,很多时候搜索引擎的爬取系统都会使用这个指标来评估网页的重要性,从而决定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量不能完全坐等别人的重视。因此,搜索引擎通常会考虑一些可靠的反向链接。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,连同要爬取的URL队列中的URL,组成一个网页集,计算每个页面的PageRank值,经过计算完成后,将要爬取的URL队列中的URL按照PageRank值的大小进行排列,依次爬取页面。

如果每个页面都被抓取,则重新计算 PageRank 值。一个折衷的方案是:每爬取K个页面后,重新计算PageRank值。但是,在这种情况下仍然存在一个问题:对于下载页面中分析的链接,即我们前面提到的未知网页部分,暂时没有PageRank值。为了解决这个问题,这些页面会被赋予一个临时的PageRank值(比如1):对这个页面所有链接传入的PageRank值进行汇总(其实大矩阵计算是重复,未知站点的PageRank值会逐渐收敛到它的期望值。说实话,收敛是我个人认为这个算法最漂亮的部分),从而形成未知页面的PageRank值,

5.OPIC 策略 策略

该算法实际上对页面的重要性进行评分。在算法开始之前,给所有页面相同的初始现金(cash)。下载某个页面P后,将P的现金分配给所有从P解析的链接,清空P的现金。待抓取的 URL 队列中的所有页面均按照现金的数量进行排序。

6.大站优先策略

URL队列中所有要爬取的网页,按照所属的网站进行分类。网站需要下载的页面较多,优先下载。这种策略因此被称为大站优先策略。

在下面 查看全部

c爬虫抓取网页数据(网络爬虫的基本工作流程:1.的发展基本流程)

下面是一个很有启发的文章先分享给大家。

信息论的发展

通过上一篇我们了解了爬虫的具体工作后,我们分析的网络爬虫的基本工作流程如下:

1.首先选择一些精心挑选的种子网址;

2.将这些URL放入URL队列进行抓取;

3. 从待爬取的URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,并存入下载的网页库中。另外,将这些网址放入已爬取的网址队列中。

4.对爬取的URL队列中的URL进行分析,分析其中的其他URL,将这些URL放入URL队列进行爬取,从而进入下一个循环。

一、爬虫设计

从爬虫的角度来划分互联网,互联网的所有页面可以分为五个部分:

1.下载了未过期的网页

2.已下载并过期的网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态变化的,互联网上的部分内容已经发生了变化。此时,这部分爬取到的页面已经过期。

3.要下载的页面:URL队列中要爬取的那些页面

4. 已知网页:尚未被抓取,也不在待抓取的 URL 队列中,但通过分析抓取的页面或待抓取的 URL 对应的页面得到的 URL,被认为是一个已知网页。

5. 还有一些网页是爬虫无法直接抓取下载的。它被称为不可知页面。

我们爬虫项目的主要事件流程大致如下:

1.获取命令行参数并进行相应操作

2. 读取配置文件,解析各种设置

3.加载各种模块

4. 种子入队,启动DNS解析线程(原队列不为空时解析)

5.创建epoll,启动任务,发起请求等,关注事件

6.在while循环中,使用epoll_wait返回active事件,每个事件启动一个线程处理(线程主要解析页面,保存页面,url处理等),可能在开始一个新的任务线程的结尾。(或者在程序初始化的时候创建一个线程池,没有任务的时候阻塞线程,通过pthread_cond_signal唤醒睡眠队列中的线程,但是一个页面解析出来的有效url会很多。这个时候,我们甚至需要在队列满时阻塞分析页面url线程,使用线程池的好处是减少线程创建和销毁的系统开销)

在爬虫系统中,要爬取的URL队列是一个非常重要的部分。URL队列中要爬取的URL按什么顺序排列也是一个很重要的问题,因为它涉及到先爬哪个页面,后爬哪个页面。确定这些 URL 顺序的方法称为抓取策略。下面重点介绍几种常见的爬取策略(关于爬取策略优劣分析的建议,请阅读吴军老师《数学之美》第9章和第10章):

1.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,逐个跟踪每一个链接,处理完这一行后转移到下一个起始页,继续跟踪链接。

2.广度优先遍历策略

广度优先遍历策略的基本思想是将新下载的网页中找到的链接直接插入到待爬取的URL队列的末尾。即网络爬虫会先抓取起始网页中所有链接的网页,然后选择其中一个链接的网页,继续抓取该网页中链接的所有网页。以上图为例:

3.反向链接计数策略

反向链接数是指从其他网页链接到某个网页的数量。反向链接的数量表示网页内容被他人推荐的程度。因此,很多时候搜索引擎的爬取系统都会使用这个指标来评估网页的重要性,从而决定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量不能完全坐等别人的重视。因此,搜索引擎通常会考虑一些可靠的反向链接。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,连同要爬取的URL队列中的URL,组成一个网页集,计算每个页面的PageRank值,经过计算完成后,将要爬取的URL队列中的URL按照PageRank值的大小进行排列,依次爬取页面。

如果每个页面都被抓取,则重新计算 PageRank 值。一个折衷的方案是:每爬取K个页面后,重新计算PageRank值。但是,在这种情况下仍然存在一个问题:对于下载页面中分析的链接,即我们前面提到的未知网页部分,暂时没有PageRank值。为了解决这个问题,这些页面会被赋予一个临时的PageRank值(比如1):对这个页面所有链接传入的PageRank值进行汇总(其实大矩阵计算是重复,未知站点的PageRank值会逐渐收敛到它的期望值。说实话,收敛是我个人认为这个算法最漂亮的部分),从而形成未知页面的PageRank值,

5.OPIC 策略 策略

该算法实际上对页面的重要性进行评分。在算法开始之前,给所有页面相同的初始现金(cash)。下载某个页面P后,将P的现金分配给所有从P解析的链接,清空P的现金。待抓取的 URL 队列中的所有页面均按照现金的数量进行排序。

6.大站优先策略

URL队列中所有要爬取的网页,按照所属的网站进行分类。网站需要下载的页面较多,优先下载。这种策略因此被称为大站优先策略。

在下面

c爬虫抓取网页数据(电商商品评论网络抓取实战_阿里巴巴开发者网站_uweb3_)

网站优化 • 优采云 发表了文章 • 0 个评论 • 44 次浏览 • 2021-12-04 19:03

c爬虫抓取网页数据一直让很多新手望而却步,原因在于现在网站抓取都是网页直接生成request的连接,这样必然会存在一些风险。本人建议使用爬虫+request协同工作,这样可以有效避免那些意外。在爬虫和request协同工作中首先有一点非常重要:会抓取的人一定会使用request协同工作,而不会抓取的人就有可能需要使用网页下载工具。

那么可以告诉你现在最流行的两个,一个是python爬虫,一个是开源项目(代替request协同工作)scrapy。scrapy开源抓取第一步先去官网了解下scrapy怎么用,以及scrapy有哪些接口等基础知识。下面简单举一个例子。想抓取苏宁易购苏宁商城苏宁易购商城的评论。我们用scrapy爬虫框架抓取苏宁易购苏宁易购商城买家评论的核心接口,请看下面图片。

连接商品标题连接评论内容可以看到scrapy有非常多的核心接口和beanstream,从而大大提高爬虫工作效率。接下来我们对每个接口进行详细介绍。第一个是电商商品评论接口:关于商品评论网络抓取实战_阿里巴巴开发者网站_uweb3_阿里开发者网站-阿里云大学第二个是说明库接口:itemiditemidapikeyitemidapiurl32122348674这个接口有非常丰富的布局有针对、年龄、购买次数、收货地址等信息有cookie(需要登录以后才能使用),这里用到的高级api就是get请求,但是对于经常写爬虫的同学来说要非常清楚一点就是cookie的问题,一般抓取一些新闻网站或者一些用户级别高的网站一般默认会有get请求,这种请求在不同的数据库上也都会保存到一个独立的字典中。

scrapy中的api是通过在文件的beans目录下category.py中模拟api执行来更新以上参数信息的,为了解决类似的问题,我们在python代码中要能够动态调用scrapyapi.login()api.useragent()api.userinfo()api.getspider()api.pagevalue(),以及自己本地添加一条rests.saver().save等方法。

那么不同的接口方法会有怎样的不同呢?图片中蓝色部分是接口,红色部分是相应参数。那么我们先来说一下图片中红色部分的三个参数。pagevalue类似前面讲到,实际上它是cookie。scrapy对于cookie的保存是动态的,在抓取一个网页以后scrapy会根据该网页爬取的数据状态动态保存cookie,并且随机获取爬取一个页面的cookie对应的值,比如刚才例子抓取的网站如果是user-agent返回一个json文件,一般我们会获取该user-agent中的所有cookie(ok返回json文件),这样的话这个cookie有50%的可能性和一个浏览器的host绑定,有50。 查看全部

c爬虫抓取网页数据(电商商品评论网络抓取实战_阿里巴巴开发者网站_uweb3_)

c爬虫抓取网页数据一直让很多新手望而却步,原因在于现在网站抓取都是网页直接生成request的连接,这样必然会存在一些风险。本人建议使用爬虫+request协同工作,这样可以有效避免那些意外。在爬虫和request协同工作中首先有一点非常重要:会抓取的人一定会使用request协同工作,而不会抓取的人就有可能需要使用网页下载工具。

那么可以告诉你现在最流行的两个,一个是python爬虫,一个是开源项目(代替request协同工作)scrapy。scrapy开源抓取第一步先去官网了解下scrapy怎么用,以及scrapy有哪些接口等基础知识。下面简单举一个例子。想抓取苏宁易购苏宁商城苏宁易购商城的评论。我们用scrapy爬虫框架抓取苏宁易购苏宁易购商城买家评论的核心接口,请看下面图片。

连接商品标题连接评论内容可以看到scrapy有非常多的核心接口和beanstream,从而大大提高爬虫工作效率。接下来我们对每个接口进行详细介绍。第一个是电商商品评论接口:关于商品评论网络抓取实战_阿里巴巴开发者网站_uweb3_阿里开发者网站-阿里云大学第二个是说明库接口:itemiditemidapikeyitemidapiurl32122348674这个接口有非常丰富的布局有针对、年龄、购买次数、收货地址等信息有cookie(需要登录以后才能使用),这里用到的高级api就是get请求,但是对于经常写爬虫的同学来说要非常清楚一点就是cookie的问题,一般抓取一些新闻网站或者一些用户级别高的网站一般默认会有get请求,这种请求在不同的数据库上也都会保存到一个独立的字典中。

scrapy中的api是通过在文件的beans目录下category.py中模拟api执行来更新以上参数信息的,为了解决类似的问题,我们在python代码中要能够动态调用scrapyapi.login()api.useragent()api.userinfo()api.getspider()api.pagevalue(),以及自己本地添加一条rests.saver().save等方法。

那么不同的接口方法会有怎样的不同呢?图片中蓝色部分是接口,红色部分是相应参数。那么我们先来说一下图片中红色部分的三个参数。pagevalue类似前面讲到,实际上它是cookie。scrapy对于cookie的保存是动态的,在抓取一个网页以后scrapy会根据该网页爬取的数据状态动态保存cookie,并且随机获取爬取一个页面的cookie对应的值,比如刚才例子抓取的网站如果是user-agent返回一个json文件,一般我们会获取该user-agent中的所有cookie(ok返回json文件),这样的话这个cookie有50%的可能性和一个浏览器的host绑定,有50。

c爬虫抓取网页数据(一下Linux系统Nginx查看百度蜘蛛爬虫分析的查看)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-12-03 18:25

网站SEO优化首先让百度蜘蛛频繁抓取网站信息增加权重和收录。再说说Linux系统Nginx和百度蜘蛛爬虫。本文分析nginx web服务器,具体的日志存放目录:/usr/local/nginx/logs/access.log,注意:文件不能太大,否则命令会非常消耗CPU,导致用户慢慢访问网站。

百度蜘蛛是百度搜索引擎的自动程序。它的功能是访问和采集互联网上的网页、图片、视频等内容,然后根据类别建立索引数据库,以便用户搜索您的网站网页、图片、视频等百度搜索引擎中的内容。

1. 百度蜘蛛爬取次数,具体命令如下:

cat access.log | grep Baiduspider | wc

2. 百度蜘蛛详细记录(Ctrl C可以终止),具体命令如下:

cat access.log | grep Baiduspider

或者

cat access.log | grep Baiduspider | tail -n 10

cat access.log | grep Baiduspider | head -n 10

上面的命令只查看前 10 个或后 10 个。

3. 百度蜘蛛抓取首页的详细记录,具体命令如下:

cat access.log | grep Baiduspider | grep “GET / HTTP”

注:百度蜘蛛对首页更敏感,而谷歌和雅虎蜘蛛更热衷于内页

4. 百度蜘蛛派记录时间分布,具体命令如下:

cat access.log | grep “Baiduspider ” | awk ‘{print $4}'

5. 百度蜘蛛抓取页面按照次数降序排列,具体命令如下:

cat access.log | grep “Baiduspider ” | awk ‘{print $7}' | sort | uniq -c | sort -r

注意:如果将文章中的Baiduspider改为Googlebot,可以查看Google的数据。鉴于大陆的特殊性,大家应该多关注百度的日志。

附件:(Mediapartners-Google)谷歌adsense爬虫详细爬取记录

cat access.log | grep Mediapartners

Googlebot 是指 Google 的机器人或蜘蛛。通常,Google 会让不同的 Googlebot 处理您的网络内容,包括:

1. 抓取文本内容,获取内容并保存在谷歌网页搜索和新闻搜索的数据库中。

2.Googlebot-mobile:它的功能是抓取网页中的文字内容,供手机用户搜索。

3.Googlebot-Image:抓取网页上的图片内容,保存到谷歌图片搜索数据库中。

4.Mediapartners-Google:抓取网页中的文本内容以进行 Google Adsense 分析关键词。Mediapartners-Google 调查只会抓取带有 Google Adsense 的网页。

5.Adsbot-Google:抓取网页中的文字内容,为Google AdWords提供参考。Adsbot-Google 探针只会抓取 Google AdWords 的着陆页。 查看全部

c爬虫抓取网页数据(一下Linux系统Nginx查看百度蜘蛛爬虫分析的查看)

网站SEO优化首先让百度蜘蛛频繁抓取网站信息增加权重和收录。再说说Linux系统Nginx和百度蜘蛛爬虫。本文分析nginx web服务器,具体的日志存放目录:/usr/local/nginx/logs/access.log,注意:文件不能太大,否则命令会非常消耗CPU,导致用户慢慢访问网站。

百度蜘蛛是百度搜索引擎的自动程序。它的功能是访问和采集互联网上的网页、图片、视频等内容,然后根据类别建立索引数据库,以便用户搜索您的网站网页、图片、视频等百度搜索引擎中的内容。

1. 百度蜘蛛爬取次数,具体命令如下:

cat access.log | grep Baiduspider | wc

2. 百度蜘蛛详细记录(Ctrl C可以终止),具体命令如下:

cat access.log | grep Baiduspider

或者

cat access.log | grep Baiduspider | tail -n 10

cat access.log | grep Baiduspider | head -n 10

上面的命令只查看前 10 个或后 10 个。

3. 百度蜘蛛抓取首页的详细记录,具体命令如下:

cat access.log | grep Baiduspider | grep “GET / HTTP”

注:百度蜘蛛对首页更敏感,而谷歌和雅虎蜘蛛更热衷于内页

4. 百度蜘蛛派记录时间分布,具体命令如下:

cat access.log | grep “Baiduspider ” | awk ‘{print $4}'

5. 百度蜘蛛抓取页面按照次数降序排列,具体命令如下:

cat access.log | grep “Baiduspider ” | awk ‘{print $7}' | sort | uniq -c | sort -r

注意:如果将文章中的Baiduspider改为Googlebot,可以查看Google的数据。鉴于大陆的特殊性,大家应该多关注百度的日志。

附件:(Mediapartners-Google)谷歌adsense爬虫详细爬取记录

cat access.log | grep Mediapartners

Googlebot 是指 Google 的机器人或蜘蛛。通常,Google 会让不同的 Googlebot 处理您的网络内容,包括:

1. 抓取文本内容,获取内容并保存在谷歌网页搜索和新闻搜索的数据库中。

2.Googlebot-mobile:它的功能是抓取网页中的文字内容,供手机用户搜索。

3.Googlebot-Image:抓取网页上的图片内容,保存到谷歌图片搜索数据库中。

4.Mediapartners-Google:抓取网页中的文本内容以进行 Google Adsense 分析关键词。Mediapartners-Google 调查只会抓取带有 Google Adsense 的网页。

5.Adsbot-Google:抓取网页中的文字内容,为Google AdWords提供参考。Adsbot-Google 探针只会抓取 Google AdWords 的着陆页。

c爬虫抓取网页数据( 简单网络@2011-09-0710:26小虾Joe阅读(6))

网站优化 • 优采云 发表了文章 • 0 个评论 • 34 次浏览 • 2021-12-03 17:28

简单网络@2011-09-0710:26小虾Joe阅读(6))

C#抓取网页Html源码(网络爬虫)

简单的网络爬虫的实现方法

我刚刚完成了一个简单的网络爬虫,因为我在做的时候就像一只无头苍蝇一样在互联网上寻找信息。找了很多资料,但确实能满足我的需求,有用的资料——代码难找。所以想发这个文章,让一些想做这个功能的朋友少走弯路。

首先是抓取Html源码,选择节点的href: to add using System.IO; 使用 System.Net;

private void Search(string url)

{

string rl;

WebRequest Request = WebRequest.Create(url.Trim());

WebResponse Response = Request.GetResponse();

Stream resStream = Response.GetResponseStream();

StreamReader sr = new StreamReader(resStream, Encoding.Default);

StringBuilder sb = new StringBuilder();

while ((rl = sr.ReadLine()) != null)

{

sb.Append(rl);

}

string str = sb.ToString().ToLower();

string str_get = mid(str, "", "");

int start = 0;

while (true)

{

if (str_get == null)

break;

string strResult = mid(str_get, "href=\"", "\"", out start);

if (strResult == null)

break;

else

{

lab[url] += strResult;

str_get = str_get.Substring(start);

}

}

}

private string mid(string istr, string startString, string endString)

{

int iBodyStart = istr.IndexOf(startString, 0); //开始位置

if (iBodyStart == -1)

return null;

iBodyStart += startString.Length; //第一次字符位置起的长度

int iBodyEnd = istr.IndexOf(endString, iBodyStart); //第二次字符在第一次字符位置起的首次位置

if (iBodyEnd == -1)

return null;

iBodyEnd += endString.Length; //第二次字符位置起的长度

string strResult = istr.Substring(iBodyStart, iBodyEnd - iBodyStart - 1);

return strResult;

}

private string mid(string istr, string startString, string endString, out int iBodyEnd)

{

//初始化out参数,否则不能return

iBodyEnd = 0;

int iBodyStart = istr.IndexOf(startString, 0); //开始位置

if (iBodyStart == -1)

return null;

iBodyStart += startString.Length; //第一次字符位置起的长度

iBodyEnd = istr.IndexOf(endString, iBodyStart); //第二次字符在第一次字符位置起的首次位置

if (iBodyEnd == -1)

return null;

iBodyEnd += endString.Length; //第二次字符位置起的长度

string strResult = istr.Substring(iBodyStart, iBodyEnd - iBodyStart - 1);

return strResult;

}

好了,以上就是全部代码了,要运行的话,有些细节还得自己修改。

发表于@2011-09-07 10:26 小虾乔阅读(12296)评论(6)编辑 查看全部

c爬虫抓取网页数据(

简单网络@2011-09-0710:26小虾Joe阅读(6))

C#抓取网页Html源码(网络爬虫)

简单的网络爬虫的实现方法

我刚刚完成了一个简单的网络爬虫,因为我在做的时候就像一只无头苍蝇一样在互联网上寻找信息。找了很多资料,但确实能满足我的需求,有用的资料——代码难找。所以想发这个文章,让一些想做这个功能的朋友少走弯路。

首先是抓取Html源码,选择节点的href: to add using System.IO; 使用 System.Net;

private void Search(string url)

{

string rl;

WebRequest Request = WebRequest.Create(url.Trim());

WebResponse Response = Request.GetResponse();

Stream resStream = Response.GetResponseStream();

StreamReader sr = new StreamReader(resStream, Encoding.Default);

StringBuilder sb = new StringBuilder();

while ((rl = sr.ReadLine()) != null)

{

sb.Append(rl);

}

string str = sb.ToString().ToLower();

string str_get = mid(str, "", "");

int start = 0;

while (true)

{

if (str_get == null)

break;

string strResult = mid(str_get, "href=\"", "\"", out start);

if (strResult == null)

break;

else

{

lab[url] += strResult;

str_get = str_get.Substring(start);

}

}

}

private string mid(string istr, string startString, string endString)

{

int iBodyStart = istr.IndexOf(startString, 0); //开始位置

if (iBodyStart == -1)

return null;

iBodyStart += startString.Length; //第一次字符位置起的长度

int iBodyEnd = istr.IndexOf(endString, iBodyStart); //第二次字符在第一次字符位置起的首次位置

if (iBodyEnd == -1)

return null;

iBodyEnd += endString.Length; //第二次字符位置起的长度

string strResult = istr.Substring(iBodyStart, iBodyEnd - iBodyStart - 1);

return strResult;

}

private string mid(string istr, string startString, string endString, out int iBodyEnd)

{

//初始化out参数,否则不能return

iBodyEnd = 0;

int iBodyStart = istr.IndexOf(startString, 0); //开始位置

if (iBodyStart == -1)

return null;

iBodyStart += startString.Length; //第一次字符位置起的长度

iBodyEnd = istr.IndexOf(endString, iBodyStart); //第二次字符在第一次字符位置起的首次位置

if (iBodyEnd == -1)

return null;

iBodyEnd += endString.Length; //第二次字符位置起的长度

string strResult = istr.Substring(iBodyStart, iBodyEnd - iBodyStart - 1);

return strResult;

}

好了,以上就是全部代码了,要运行的话,有些细节还得自己修改。

发表于@2011-09-07 10:26 小虾乔阅读(12296)评论(6)编辑

c爬虫抓取网页数据(聚焦爬虫使用方法的如下如下|)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-03 08:06

01 专注爬虫技术

聚焦爬虫(focused crawler)也是主题网络爬虫。聚焦爬虫技术增加了链接评价和内容评价模块。其抓取策略的关键是评估页面内容和链接的重要性。

基于链接评估的爬取策略主要是将网页作为半结构化文档,其中收录大量的结构化信息,可用于评估链接的重要性。还有一种利用Web结构来评估链接价值的方法,即HITS方法,它通过计算每个访问页面的Authority weight和Hub weight来确定链接访问的顺序。

基于内容评价的爬取策略主要应用类似于文本的计算方法,提出以用户输入查询为主题的Fish-Search算法。随着算法的进一步改进,可以通过Shark-Search算法使用。空间向量模型用于计算页面和主题之间的相关性。

面向主题的爬虫,面向需求的爬虫:会针对特定的内容爬取信息,并且会尽可能保证信息和需求的相关性。下面显示了如何使用聚焦爬虫的简单示例。

import urllib.request

# 爬虫专用的包urllib,不同版本的Python需要下载不同的爬虫专用包

import re

# 正则用来规律爬取

keyname=""

# 想要爬取的内容

key=urllib.request.quote(keyname)

# 需要将你输入的keyname解码,从而让计算机读懂

for i in range(0,5): # (0,5)数字可以自己设置,是淘宝某产品的页数

url="https://s.taobao.com/search%3F ... 2Bstr(i*44)

# url后面加上你想爬取的网站名,然后你需要多开几个类似的网站以找到其规则

# data是你爬取到的网站所有的内容要解码要读取内容

pat='"pic_url":"//(.*?)"'

# pat使用正则表达式从网页爬取图片

# 将你爬取到的内容放在一个列表里面

print(picturelist)

# 可以不打印,也可以打印下来看看

for j in range(0,len(picturelist)):

picture=picturelist[j]

pictureurl="http://"+picture

# 将列表里的内容遍历出来,并加上http://转到高清图片

file="E:/pycharm/vscode文件/图片/"+str(i)+str(j)+".jpg"

# 再把图片逐张编号,不然重复的名字将会被覆盖掉

urllib.request.urlretrieve(pictureurl,filename=file)

# 最后保存到文件夹

02 通用履带技术

通用网络爬虫技术(general purpose Web crawler)也就是整个网络爬虫。实现过程如下。

通用爬虫技术的应用有不同的爬取策略。广度优先策略和深度优先策略都更为关键。例如,深度优先策略的实现是按照深度从低到高的顺序访问下一级的网页链接。

如何使用通用爬虫的示例如下。

'''

爬取京东商品信息:

请求url:https://www.jd.com/

提取商品信息:

1.商品详情页

2.商品名称

3.商品价格

4.评价人数

5.商品商家

'''

from selenium import webdriver # 引入selenium中的webdriver

from selenium.webdriver.common.keys import Keys

import time

def get_good(driver):

try:

# 通过JS控制滚轮滑动获取所有商品信息

js_code = '''

window.scrollTo(0,5000);

'''

driver.execute_script(js_code) # 执行js代码

# 等待数据加载

time.sleep(2)

# 查找所有商品div

# good_div = driver.find_element_by_id('J_goodsList')

good_list = driver.find_elements_by_class_name('gl-item')

n = 1

for good in good_list:

# 根据属性选择器查找

# 商品链接

good_url = good.find_element_by_css_selector(

'.p-img a').get_attribute('href')

# 商品名称

good_name = good.find_element_by_css_selector(

'.p-name em').text.replace("\n", "--")

# 商品价格

good_price = good.find_element_by_class_name(

'p-price').text.replace("\n", ":")

# 评价人数

good_commit = good.find_element_by_class_name(

'p-commit').text.replace("\n", " ")

good_content = f'''

商品链接: {good_url}

商品名称: {good_name}

商品价格: {good_price}

评价人数: {good_commit}

\n

'''

print(good_content)

with open('jd.txt', 'a', encoding='utf-8') as f:

f.write(good_content)

next_tag = driver.find_element_by_class_name('pn-next')

next_tag.click()

time.sleep(2)

# 递归调用函数

get_good(driver)

time.sleep(10)

finally:

driver.close()

if __name__ == '__main__':

good_name = input('请输入爬取商品信息:').strip()

driver = webdriver.Chrome()

driver.implicitly_wait(10)

# 往京东主页发送请求

driver.get('https://www.jd.com/')

# 输入商品名称,并回车搜索

input_tag = driver.find_element_by_id('key')

input_tag.send_keys(good_name)

input_tag.send_keys(Keys.ENTER)

time.sleep(2)

get_good(driver)

03 增量爬虫技术

有些网站会在原创网页数据的基础上,定期更新一批数据。比如某部电影网站会实时更新一批近期的热门电影,小说网站会根据作者的创作进度实时更新最新的章节数据。遇到类似场景,我们可以使用增量爬虫。

增量网络爬虫技术(incremental Web crawler)就是通过爬虫程序监控某网站数据的更新,从而可以爬取网站更新后的新数据。

关于如何进行增量爬取,下面给出了三种检测重复数据的思路:

发送请求前,判断该URL是否已被爬取;解析内容后,判断这部分内容是否已经被爬取;在写入存储介质时,判断介质中是否已经存在该内容。

不难发现,实现增量爬取的核心是去重。目前有两种重复数据删除方法。

下面显示了如何使用增量爬虫的示例。

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from redis import Redis

from incrementPro.items import IncrementproItem

class MovieSpider(CrawlSpider):

name = 'movie'

# allowed_domains = ['www.xxx.com']

start_urls = ['http://www.4567tv.tv/frim/index7-11.html']

rules = (

Rule(LinkExtractor(allow=r'/frim/index7-\d+\.html'), callback='parse_item', follow=True),

)

# 创建Redis链接对象

conn = Redis(host='127.0.0.1', port=6379)

def parse_item(self, response):

li_list = response.xpath('//li[@class="p1 m1"]')

for li in li_list:

# 获取详情页的url

detail_url = 'http://www.4567tv.tv' + li.xpath('./a/@href').extract_first()

# 将详情页的url存入Redis的set中

ex = self.conn.sadd('urls', detail_url)

if ex == 1:

print('该url没有被爬取过,可以进行数据的爬取')

yield scrapy.Request(url=detail_url, callback=self.parst_detail)

else:

print('数据还没有更新,暂无新数据可爬取!')

# 解析详情页中的电影名称和类型,进行持久化存储

def parst_detail(self, response):

item = IncrementproItem()

item['name'] = response.xpath('//dt[@class="name"]/text()').extract_first()

item['kind'] = response.xpath('//div[@class="ct-c"]/dl/dt[4]//text()').extract()

item['kind'] = ''.join(item['kind'])

yield it

管道文件:

from redis import Redis

class IncrementproPipeline(object):

conn = None

def open_spider(self,spider):

self.conn = Redis(host='127.0.0.1',port=6379)

def process_item(self, item, spider):

dic = {

'name':item['name'],

'kind':item['kind']

}

print(dic)

self.conn.push('movieData',dic)

# 如果push不进去,那么dic变成str(dic)或者改变redis版本

pip install -U redis==2.10.6

return item

04 深网爬虫技术

在互联网中,网页按存在方式可分为表面网页和深层网页两种。

所谓地表网页,是指不用提交表单,通过静态链接就可以到达的静态页面;而深层网页隐藏在表单后面,无法通过静态链接直接获取。需要提交一定数量的关键词。后面可以获取的页面中最重要的部分是表单填写部分。

在互联网中,深层网页的数量往往远大于表面网页的数量。因此,我们需要找到一种爬取深层网页的方法。

深网爬虫的基本组成:URL列表、LVS列表(LVS是指标签/值集合,即填写表单的数据源)、爬虫控制器、解析器、LVS控制器、表单分析器、表单处理器、响应分析器。

深度网络爬虫有两种表单填写方式: 查看全部

c爬虫抓取网页数据(聚焦爬虫使用方法的如下如下|)

01 专注爬虫技术

聚焦爬虫(focused crawler)也是主题网络爬虫。聚焦爬虫技术增加了链接评价和内容评价模块。其抓取策略的关键是评估页面内容和链接的重要性。

基于链接评估的爬取策略主要是将网页作为半结构化文档,其中收录大量的结构化信息,可用于评估链接的重要性。还有一种利用Web结构来评估链接价值的方法,即HITS方法,它通过计算每个访问页面的Authority weight和Hub weight来确定链接访问的顺序。

基于内容评价的爬取策略主要应用类似于文本的计算方法,提出以用户输入查询为主题的Fish-Search算法。随着算法的进一步改进,可以通过Shark-Search算法使用。空间向量模型用于计算页面和主题之间的相关性。

面向主题的爬虫,面向需求的爬虫:会针对特定的内容爬取信息,并且会尽可能保证信息和需求的相关性。下面显示了如何使用聚焦爬虫的简单示例。

import urllib.request

# 爬虫专用的包urllib,不同版本的Python需要下载不同的爬虫专用包

import re

# 正则用来规律爬取

keyname=""

# 想要爬取的内容

key=urllib.request.quote(keyname)

# 需要将你输入的keyname解码,从而让计算机读懂

for i in range(0,5): # (0,5)数字可以自己设置,是淘宝某产品的页数

url="https://s.taobao.com/search%3F ... 2Bstr(i*44)

# url后面加上你想爬取的网站名,然后你需要多开几个类似的网站以找到其规则

# data是你爬取到的网站所有的内容要解码要读取内容

pat='"pic_url":"//(.*?)"'

# pat使用正则表达式从网页爬取图片

# 将你爬取到的内容放在一个列表里面

print(picturelist)

# 可以不打印,也可以打印下来看看

for j in range(0,len(picturelist)):

picture=picturelist[j]

pictureurl="http://"+picture

# 将列表里的内容遍历出来,并加上http://转到高清图片

file="E:/pycharm/vscode文件/图片/"+str(i)+str(j)+".jpg"

# 再把图片逐张编号,不然重复的名字将会被覆盖掉

urllib.request.urlretrieve(pictureurl,filename=file)

# 最后保存到文件夹

02 通用履带技术

通用网络爬虫技术(general purpose Web crawler)也就是整个网络爬虫。实现过程如下。

通用爬虫技术的应用有不同的爬取策略。广度优先策略和深度优先策略都更为关键。例如,深度优先策略的实现是按照深度从低到高的顺序访问下一级的网页链接。

如何使用通用爬虫的示例如下。

'''

爬取京东商品信息:

请求url:https://www.jd.com/

提取商品信息:

1.商品详情页

2.商品名称

3.商品价格

4.评价人数

5.商品商家

'''

from selenium import webdriver # 引入selenium中的webdriver

from selenium.webdriver.common.keys import Keys

import time

def get_good(driver):

try:

# 通过JS控制滚轮滑动获取所有商品信息

js_code = '''

window.scrollTo(0,5000);

'''

driver.execute_script(js_code) # 执行js代码

# 等待数据加载

time.sleep(2)

# 查找所有商品div

# good_div = driver.find_element_by_id('J_goodsList')

good_list = driver.find_elements_by_class_name('gl-item')

n = 1

for good in good_list:

# 根据属性选择器查找

# 商品链接

good_url = good.find_element_by_css_selector(

'.p-img a').get_attribute('href')

# 商品名称

good_name = good.find_element_by_css_selector(

'.p-name em').text.replace("\n", "--")

# 商品价格

good_price = good.find_element_by_class_name(

'p-price').text.replace("\n", ":")

# 评价人数

good_commit = good.find_element_by_class_name(

'p-commit').text.replace("\n", " ")

good_content = f'''

商品链接: {good_url}

商品名称: {good_name}

商品价格: {good_price}

评价人数: {good_commit}

\n

'''

print(good_content)

with open('jd.txt', 'a', encoding='utf-8') as f:

f.write(good_content)

next_tag = driver.find_element_by_class_name('pn-next')

next_tag.click()

time.sleep(2)

# 递归调用函数

get_good(driver)

time.sleep(10)

finally:

driver.close()

if __name__ == '__main__':

good_name = input('请输入爬取商品信息:').strip()

driver = webdriver.Chrome()

driver.implicitly_wait(10)

# 往京东主页发送请求

driver.get('https://www.jd.com/')

# 输入商品名称,并回车搜索

input_tag = driver.find_element_by_id('key')

input_tag.send_keys(good_name)

input_tag.send_keys(Keys.ENTER)

time.sleep(2)

get_good(driver)

03 增量爬虫技术

有些网站会在原创网页数据的基础上,定期更新一批数据。比如某部电影网站会实时更新一批近期的热门电影,小说网站会根据作者的创作进度实时更新最新的章节数据。遇到类似场景,我们可以使用增量爬虫。

增量网络爬虫技术(incremental Web crawler)就是通过爬虫程序监控某网站数据的更新,从而可以爬取网站更新后的新数据。

关于如何进行增量爬取,下面给出了三种检测重复数据的思路:

发送请求前,判断该URL是否已被爬取;解析内容后,判断这部分内容是否已经被爬取;在写入存储介质时,判断介质中是否已经存在该内容。

不难发现,实现增量爬取的核心是去重。目前有两种重复数据删除方法。

下面显示了如何使用增量爬虫的示例。

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from redis import Redis

from incrementPro.items import IncrementproItem

class MovieSpider(CrawlSpider):

name = 'movie'

# allowed_domains = ['www.xxx.com']

start_urls = ['http://www.4567tv.tv/frim/index7-11.html']

rules = (

Rule(LinkExtractor(allow=r'/frim/index7-\d+\.html'), callback='parse_item', follow=True),

)

# 创建Redis链接对象

conn = Redis(host='127.0.0.1', port=6379)

def parse_item(self, response):

li_list = response.xpath('//li[@class="p1 m1"]')

for li in li_list:

# 获取详情页的url

detail_url = 'http://www.4567tv.tv' + li.xpath('./a/@href').extract_first()

# 将详情页的url存入Redis的set中

ex = self.conn.sadd('urls', detail_url)

if ex == 1:

print('该url没有被爬取过,可以进行数据的爬取')

yield scrapy.Request(url=detail_url, callback=self.parst_detail)

else:

print('数据还没有更新,暂无新数据可爬取!')

# 解析详情页中的电影名称和类型,进行持久化存储

def parst_detail(self, response):

item = IncrementproItem()

item['name'] = response.xpath('//dt[@class="name"]/text()').extract_first()

item['kind'] = response.xpath('//div[@class="ct-c"]/dl/dt[4]//text()').extract()

item['kind'] = ''.join(item['kind'])

yield it

管道文件:

from redis import Redis

class IncrementproPipeline(object):

conn = None

def open_spider(self,spider):

self.conn = Redis(host='127.0.0.1',port=6379)

def process_item(self, item, spider):

dic = {

'name':item['name'],

'kind':item['kind']

}

print(dic)

self.conn.push('movieData',dic)

# 如果push不进去,那么dic变成str(dic)或者改变redis版本

pip install -U redis==2.10.6

return item

04 深网爬虫技术

在互联网中,网页按存在方式可分为表面网页和深层网页两种。

所谓地表网页,是指不用提交表单,通过静态链接就可以到达的静态页面;而深层网页隐藏在表单后面,无法通过静态链接直接获取。需要提交一定数量的关键词。后面可以获取的页面中最重要的部分是表单填写部分。

在互联网中,深层网页的数量往往远大于表面网页的数量。因此,我们需要找到一种爬取深层网页的方法。

深网爬虫的基本组成:URL列表、LVS列表(LVS是指标签/值集合,即填写表单的数据源)、爬虫控制器、解析器、LVS控制器、表单分析器、表单处理器、响应分析器。

深度网络爬虫有两种表单填写方式:

c爬虫抓取网页数据(Python爬虫4.2—ajax[动态网页数据]用法教程综述)

网站优化 • 优采云 发表了文章 • 0 个评论 • 45 次浏览 • 2021-12-01 02:22

Python爬虫4.2——ajax【动态网页数据】使用教程

概括

本系列文档用于通过简单的教程讲解Python爬虫技术的学习。在巩固您的技术知识的同时,如果它碰巧对您有用就更好了。

Python版本为3.7.4

有时,当我们使用请求来获取页面时,我们得到的结果可能与我们在浏览器中看到的不同。在浏览器中可以看到正常显示的页面数据,但是使用请求得到的结果却看不到。这是因为获取的请求都是原创的 HTML 文档,浏览器中的页面是 JavaScript 处理数据后生成的结果。这些数据的来源有很多,可能是通过Ajax加载的,可能是收录在HTML中的,也可能是通过JavaScript和特定算法计算后生成的文档中的文档。

因此,如果遇到这样的页面,可以直接使用requests等库来抓取原创页面,无法获取有效数据。这时候就需要分析从网页后端发送到接口的Ajax请求。如果可以使用requests来模拟ajax请求,那么就可以成功爬取。

因此,在本文中,我们主要了解什么是 Ajax,以及如何分析和捕获 Ajax 请求。

AJAX介绍什么是AJAX

AJAX (Asynchronous JavaScript And XML) 异步 JavaScript 和 XML。通过后台与服务器协商的数据交换,Ajax 可以实现网页的异步更新,即可以在不重新加载整个网页的情况下更新网页的某个部分。如果需要更新传统网页的内容(不使用Ajax),则必须重新加载整个网页,因为传统的数据传输格式使用XML语法,所以称为Ajax。实际上,受限的数据交互基本上是使用JSON和Ajax加载的数据。即使使用JS将数据渲染到浏览器中,在查看网页源代码时也看不到通过Ajax加载的数据。你只能看到使用这个 url 加载的 HTML 代码。

示例说明

在浏览网页时,我们会发现很多网页都有向下滚动查看更多选项的功能。比如微博、今日头条等,有的会根据鼠标下拉自动加载,这些其实就是ajax加载的过程。我们可以看到页面并没有完全刷新,也就是说页面的链接没有改变,但是页面中有新的内容,这就是获取新数据并通过ajax呈现的过程。

请求分析

使用 Chrome 开发者工具的过滤功能过滤掉所有的 Ajax 请求,这里不再详细说明。

Fiddler抓包工具也可以用于抓包分析。Fiddler工具的使用这里不做说明,大家可以网上搜索查看。

Ajax 响应结果一般为json 数据格式。

获取方法直接分析Ajax使用的接口,然后通过代码请求这个接口获取数据(下面的例子就是这么一个普通)。使用Selenium + Chromedriver模拟浏览器行为获取数据(文章后面会继续介绍)。方式优缺点

分析界面

可直接请求数据,无需分析工作,代码量小,性能高。

分析接口比较复杂,尤其是一些被js混淆的接口,必须有一定的js知识,发现很容易被爬取。

硒

直接模拟浏览器的行为。浏览器可以请求的也可以使用selenium来请求。爬虫更稳定。

代码量大,性能低。

示例说明

举个例子,爬取“当一个长得好看的程序员是什么感觉?”这个问题的所有答案。在 知乎 下。示例代码如下:

<p># 引入所需库

import json

import requests

# 声明定义请求头

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) '

'AppleWebKit/537.36 (KHTML, '

'like Gecko) Chrome/67.0.3396.99 '

'Safari/537.36',

'Host': "www.zhihu.com",

'Referer': "https://www.zhihu.com/question/37787176"

}

def answer(url_):

"""

获取问题答案

:param url_:

:return:

"""

r = requests.get(url_, headers=header)

data = r.text

jsonobj = json.loads(data)

return jsonobj

# 问题答案接口地址

url = "https://www.zhihu.com/api/v4/q ... ot%3B

# 获取回答总数

answer_total = int(answer(url)['paging']['totals'])

offset = 0

while offset 查看全部

c爬虫抓取网页数据(Python爬虫4.2—ajax[动态网页数据]用法教程综述)

Python爬虫4.2——ajax【动态网页数据】使用教程

概括

本系列文档用于通过简单的教程讲解Python爬虫技术的学习。在巩固您的技术知识的同时,如果它碰巧对您有用就更好了。

Python版本为3.7.4

有时,当我们使用请求来获取页面时,我们得到的结果可能与我们在浏览器中看到的不同。在浏览器中可以看到正常显示的页面数据,但是使用请求得到的结果却看不到。这是因为获取的请求都是原创的 HTML 文档,浏览器中的页面是 JavaScript 处理数据后生成的结果。这些数据的来源有很多,可能是通过Ajax加载的,可能是收录在HTML中的,也可能是通过JavaScript和特定算法计算后生成的文档中的文档。

因此,如果遇到这样的页面,可以直接使用requests等库来抓取原创页面,无法获取有效数据。这时候就需要分析从网页后端发送到接口的Ajax请求。如果可以使用requests来模拟ajax请求,那么就可以成功爬取。

因此,在本文中,我们主要了解什么是 Ajax,以及如何分析和捕获 Ajax 请求。

AJAX介绍什么是AJAX

AJAX (Asynchronous JavaScript And XML) 异步 JavaScript 和 XML。通过后台与服务器协商的数据交换,Ajax 可以实现网页的异步更新,即可以在不重新加载整个网页的情况下更新网页的某个部分。如果需要更新传统网页的内容(不使用Ajax),则必须重新加载整个网页,因为传统的数据传输格式使用XML语法,所以称为Ajax。实际上,受限的数据交互基本上是使用JSON和Ajax加载的数据。即使使用JS将数据渲染到浏览器中,在查看网页源代码时也看不到通过Ajax加载的数据。你只能看到使用这个 url 加载的 HTML 代码。

示例说明

在浏览网页时,我们会发现很多网页都有向下滚动查看更多选项的功能。比如微博、今日头条等,有的会根据鼠标下拉自动加载,这些其实就是ajax加载的过程。我们可以看到页面并没有完全刷新,也就是说页面的链接没有改变,但是页面中有新的内容,这就是获取新数据并通过ajax呈现的过程。

请求分析

使用 Chrome 开发者工具的过滤功能过滤掉所有的 Ajax 请求,这里不再详细说明。

Fiddler抓包工具也可以用于抓包分析。Fiddler工具的使用这里不做说明,大家可以网上搜索查看。

Ajax 响应结果一般为json 数据格式。

获取方法直接分析Ajax使用的接口,然后通过代码请求这个接口获取数据(下面的例子就是这么一个普通)。使用Selenium + Chromedriver模拟浏览器行为获取数据(文章后面会继续介绍)。方式优缺点

分析界面

可直接请求数据,无需分析工作,代码量小,性能高。

分析接口比较复杂,尤其是一些被js混淆的接口,必须有一定的js知识,发现很容易被爬取。

硒

直接模拟浏览器的行为。浏览器可以请求的也可以使用selenium来请求。爬虫更稳定。

代码量大,性能低。

示例说明

举个例子,爬取“当一个长得好看的程序员是什么感觉?”这个问题的所有答案。在 知乎 下。示例代码如下:

<p># 引入所需库

import json

import requests

# 声明定义请求头

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) '

'AppleWebKit/537.36 (KHTML, '

'like Gecko) Chrome/67.0.3396.99 '

'Safari/537.36',

'Host': "www.zhihu.com",

'Referer': "https://www.zhihu.com/question/37787176"

}

def answer(url_):

"""

获取问题答案

:param url_:

:return:

"""

r = requests.get(url_, headers=header)

data = r.text

jsonobj = json.loads(data)

return jsonobj

# 问题答案接口地址

url = "https://www.zhihu.com/api/v4/q ... ot%3B

# 获取回答总数

answer_total = int(answer(url)['paging']['totals'])

offset = 0

while offset

c爬虫抓取网页数据(js代理抓取网页数据注意flash的反爬参考这个网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 47 次浏览 • 2021-11-30 06:01

c爬虫抓取网页数据抓取各种第三方网站点击插件网页加载时要注意元素选择和数据解析方式设置js代理抓取app获取数据注意flash的反爬

参考这个网站:bytegetiphonexsdevicewebstore分享中国android生态圈网站

撸串,吃麻小,

安卓环境,

随便一个教程(不做作业,

疯狂的熊猫pptv视频,

怎么样才能快速学会python爬虫,

aso100

appad

http

我看楼上的答案都是些什么web爬虫爬虫呢,上个google,mediaq里面有所有中文网站,爬一爬你就懂了,python可以做。

在我看来网页爬虫最重要的就是http协议。不仅能下载热门网站的资源,还能下载有害网站。主要还是看业务形式。

我来说个好玩的~~

爬论坛~~

rubyweb程序,你看,如果给你几分钟做一个爬虫,你能获得最全面的资源,效率最高,是不是很神奇。

如果给你几分钟,弄一个爬虫,你能获得最全面的资源,效率最高,是不是很神奇。 查看全部

c爬虫抓取网页数据(js代理抓取网页数据注意flash的反爬参考这个网站)

c爬虫抓取网页数据抓取各种第三方网站点击插件网页加载时要注意元素选择和数据解析方式设置js代理抓取app获取数据注意flash的反爬

参考这个网站:bytegetiphonexsdevicewebstore分享中国android生态圈网站

撸串,吃麻小,

安卓环境,

随便一个教程(不做作业,

疯狂的熊猫pptv视频,

怎么样才能快速学会python爬虫,

aso100

appad

http

我看楼上的答案都是些什么web爬虫爬虫呢,上个google,mediaq里面有所有中文网站,爬一爬你就懂了,python可以做。

在我看来网页爬虫最重要的就是http协议。不仅能下载热门网站的资源,还能下载有害网站。主要还是看业务形式。

我来说个好玩的~~

爬论坛~~

rubyweb程序,你看,如果给你几分钟做一个爬虫,你能获得最全面的资源,效率最高,是不是很神奇。

如果给你几分钟,弄一个爬虫,你能获得最全面的资源,效率最高,是不是很神奇。

c爬虫抓取网页数据(python简单网络爬虫获取网页数据获取智联招聘上一线及新一线城市)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-11-27 02:15

小编将与大家分享python爬虫抓取网页数据的方法。希望大家看完这篇文章能有所收获,一起来讨论一下吧!

Python简单的网络爬虫获取网页数据

以下是获取智联招聘一线及新一线城市所有BIM相关工作信息,以便做一些数据分析。

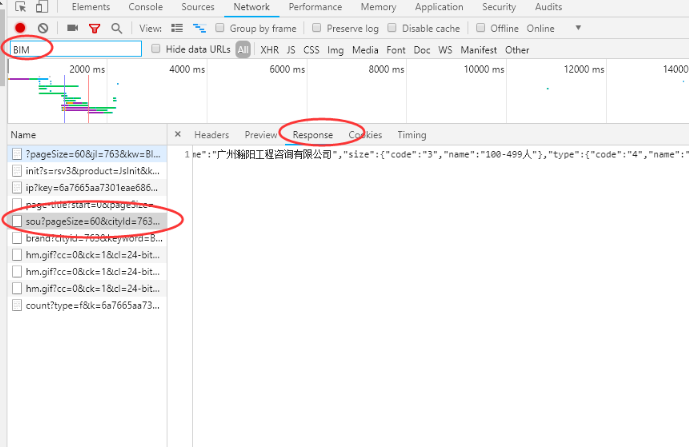

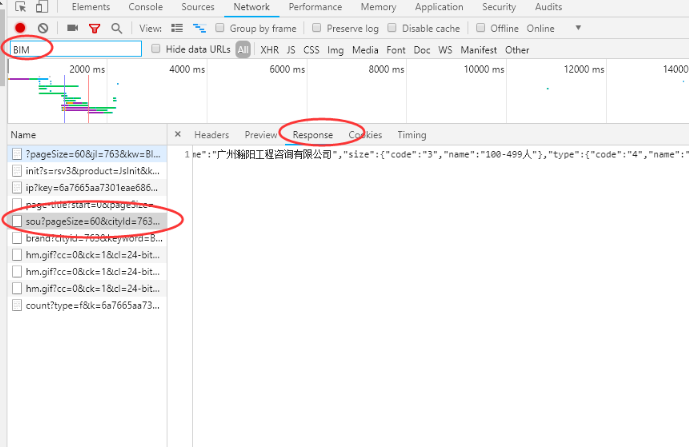

1、 先通过chrome在智联招聘上搜索BIM职位信息,跳出页面后ctrl+u查看网页源码。如果没有找到当前页面的职位信息。然后快捷键F12打开开发者工具窗口,刷新页面,通过关键字过滤文件,找到收录位置的数据包。

2、查看该文件的请求URL,分析其结构,发现数据包的请求URL为

‘https://fe-api.zhaopin.com/c/i/sou?’+请求参数组成,那么根据格式构造了一个新的url(

‘https://fe-api.zhaopin.com/c/i ... kw%3D造价员&kt=3’)

复制到浏览器进行访问测试,成功获取相应数据

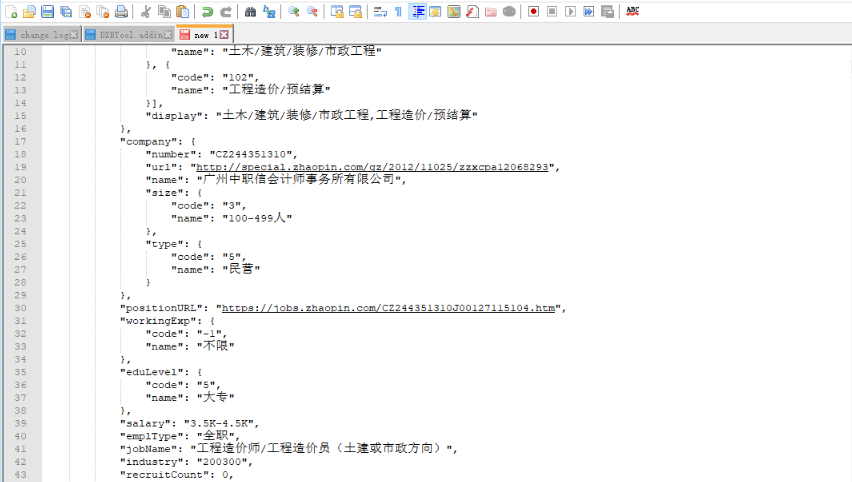

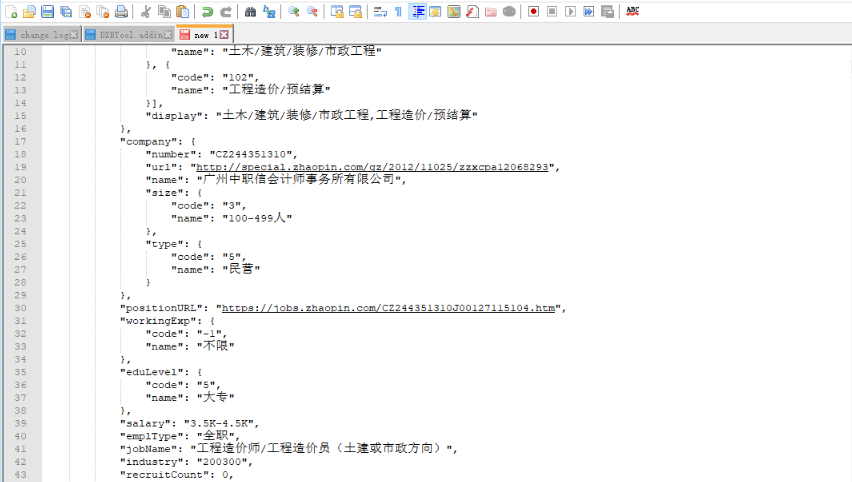

3、 获取的数据为json格式。首先对数据进行格式化,分析结构,确定代码中数据的分析方法。

4、 明确请求URL和数据结构后,剩下的就是在代码中实现URL构建、数据分析和导出。最终得到了1215条数据,需要对数据进行进一步排序进行数据分析。

看完这篇文章,相信你对python爬虫爬取网页数据的方法有了一定的了解。如果您想了解更多,请关注一宿云行业资讯频道。感谢您的阅读! 查看全部

c爬虫抓取网页数据(python简单网络爬虫获取网页数据获取智联招聘上一线及新一线城市)

小编将与大家分享python爬虫抓取网页数据的方法。希望大家看完这篇文章能有所收获,一起来讨论一下吧!

Python简单的网络爬虫获取网页数据

以下是获取智联招聘一线及新一线城市所有BIM相关工作信息,以便做一些数据分析。

1、 先通过chrome在智联招聘上搜索BIM职位信息,跳出页面后ctrl+u查看网页源码。如果没有找到当前页面的职位信息。然后快捷键F12打开开发者工具窗口,刷新页面,通过关键字过滤文件,找到收录位置的数据包。

2、查看该文件的请求URL,分析其结构,发现数据包的请求URL为

‘https://fe-api.zhaopin.com/c/i/sou?’+请求参数组成,那么根据格式构造了一个新的url(

‘https://fe-api.zhaopin.com/c/i ... kw%3D造价员&kt=3’)

复制到浏览器进行访问测试,成功获取相应数据

3、 获取的数据为json格式。首先对数据进行格式化,分析结构,确定代码中数据的分析方法。

4、 明确请求URL和数据结构后,剩下的就是在代码中实现URL构建、数据分析和导出。最终得到了1215条数据,需要对数据进行进一步排序进行数据分析。

看完这篇文章,相信你对python爬虫爬取网页数据的方法有了一定的了解。如果您想了解更多,请关注一宿云行业资讯频道。感谢您的阅读!

c爬虫抓取网页数据(爬虫是Python的一个重要的应用,使用Python爬虫我们可以轻松的从互联网中抓取 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-11-24 18:10

)

爬虫是Python的一个重要应用。使用Python爬虫,我们可以很方便的从网上抓取我们想要的数据。本文将以抓取B站视频热搜榜数据并存储为例,详细介绍Python爬虫的基本流程。如果您还处于初始爬虫阶段或者不了解爬虫的具体工作流程,那么您应该仔细阅读本文!

第 1 步:尝试请求

先到b站首页,点击排行榜,复制链接

https://www.bilibili.com/ranki ... 162.3

现在启动 Jupyter notebook 并运行以下代码

import requests

url = 'https://www.bilibili.com/ranking?spm_id_from=333.851.b_7072696d61727950616765546162.3'

res = requests.get('url')

print(res.status_code)

#200

在上面的代码中,我们完成了以下三件事

可以看到返回值为200,说明服务器响应正常,可以继续。

第二步:解析页面

上一步我们通过requests向网站请求数据后,成功获取到一个收录服务器资源的Response对象,现在可以使用.text查看其内容

可以看到返回了一个字符串,里面收录了我们需要的热门视频数据,但是直接从字符串中提取内容比较复杂,效率低下,所以我们需要对其进行解析,将字符串转换成结构化的网页数据,以便您可以轻松找到 HTML 标记及其属性和内容。

在 Python 中有很多方法可以解析网页。您可以使用正则表达式,也可以使用 BeautifulSoup、pyquery 或 lxml。本文将基于 BeautifulSoup 来解释它们。

Beautiful Soup 是一个第三方库,可以从 HTML 或 XML 文件中提取数据。安装也非常简单。使用 pip install bs4 进行安装。让我们用一个简单的例子来说明它是如何工作的

from bs4 import BeautifulSoup

page = requests.get(url)

soup = BeautifulSoup(page.content, 'html.parser')

title = soup.title.text

print(title)

# 热门视频排行榜 - 哔哩哔哩 (゜-゜)つロ 干杯~-bilibili

上面代码中,我们使用bs4中的BeautifulSoup类,将上一步得到的html格式字符串转换为BeautifulSoup对象。注意使用的时候需要开发一个解析器,这里使用的是html.parser。

然后就可以获取其中一个结构化元素及其属性,比如使用soup.title.text获取页面标题,也可以使用soup.body、soup.p等获取任意需要的元素。

第 3 步:提取内容

上面两步我们使用requests向网页请求数据,使用bs4解析页面。现在我们到了最关键的一步:如何从解析后的页面中提取需要的内容。

在 Beautiful Soup 中,我们可以使用 find/find_all 来定位元素,但我更习惯使用 CSS 选择器 .select,因为我们可以像使用 CSS 选择元素一样向下访问 DOM 树。

下面我们用代码来说明如何从解析后的页面中提取B站的热点列表数据。首先,我们需要找到存储数据的标签。在列表页面上按 F12 并按照下面的说明找到它。

可以看到每条视频信息都包裹在class="rank-item"的li标签下,那么代码可以这样写吗?

all_products = []

products = soup.select('li.rank-item')

for product in products:

rank = product.select('div.num')[0].text

name = product.select('div.info > a')[0].text.strip()

play = product.select('span.data-box')[0].text

comment = product.select('span.data-box')[1].text

up = product.select('span.data-box')[2].text

url = product.select('div.info > a')[0].attrs['href']

all_products.append({

"视频排名":rank,

"视频名": name,

"播放量": play,

"弹幕量": comment,

"up主": up,

"视频链接": url

})

上面代码中,我们先使用soup.select('li.rank-item'),然后返回一个收录每个视频信息的列表,然后遍历每个视频信息,依然使用CSS选择器提取我们想要的字段信息以字典的形式存储在开头定义的空列表中。

可以注意到,我使用了多种选择方法来提取元素。这也是select方法的灵活性。有兴趣的读者可自行进一步研究。

第 4 步:存储数据

通过前面三步,我们成功使用requests+bs4从网站中提取出需要的数据,最后只需要将数据写入Excel并保存即可。

如果你对pandas不熟悉,可以使用csv模块来编写。需要注意的是设置了encoding='utf-8-sig',否则会出现中文乱码的问题

import csv

keys = all_products[0].keys()

with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

dict_writer = csv.DictWriter(output_file, keys)

dict_writer.writeheader()

dict_writer.writerows(all_products)

如果你熟悉pandas,你可以轻松地将字典转换为DataFrame,只需一行代码

import pandas as pd

keys = all_products[0].keys()

pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

概括

至此,我们已经成功地使用Python在本地存储了b站的热门视频列表数据。大多数基于请求的爬虫基本上都是按照以上四个步骤进行的。

然而,虽然看起来简单,但在真实场景中的每一步都不是那么容易。从请求数据开始,目标网站有多种形式的反爬和加密,后期解析、提取甚至存储数据的方式也很多。需要进一步探索和学习。

本文选择B站视频热榜正是因为足够简单,希望通过这个案例,让大家了解爬取的基本过程,最后附上完整的代码

import requests

from bs4 import BeautifulSoup

import csv

import pandas as pd

url = 'https://www.bilibili.com/ranking?spm_id_from=333.851.b_7072696d61727950616765546162.3'

page = requests.get(url)

soup = BeautifulSoup(page.content, 'html.parser')

all_products = []

products = soup.select('li.rank-item')

for product in products:

rank = product.select('div.num')[0].text

name = product.select('div.info > a')[0].text.strip()

play = product.select('span.data-box')[0].text

comment = product.select('span.data-box')[1].text

up = product.select('span.data-box')[2].text

url = product.select('div.info > a')[0].attrs['href']

all_products.append({

"视频排名":rank,

"视频名": name,

"播放量": play,

"弹幕量": comment,

"up主": up,

"视频链接": url

})

keys = all_products[0].keys()

with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

dict_writer = csv.DictWriter(output_file, keys)

dict_writer.writeheader()

dict_writer.writerows(all_products)

### 使用pandas写入数据

pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

<p data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-style="letter-spacing: 0.544px; white-space: normal; font-weight: 700; widows: 1; word-spacing: 2px; color: rgb(0, 0, 0); font-family: Optima-Regular, Optima, PingFangSC-light, PingFangTC-light, "PingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif; font-size: 16px; caret-color: rgb(51, 51, 51);" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)" style="letter-spacing: 0.544px;white-space: normal;font-weight: 700;widows: 1;word-spacing: 2px;color: rgb(0, 0, 0);font-family: Optima-Regular, Optima, PingFangSC-light, PingFangTC-light, "PingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 16px;caret-color: rgb(51, 51, 51);"><br mpa-from-tpl="t" data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)">

由于微信平台算法改版,公号内容将不再以时间排序展示,如果大家想第一时间看到我们的推送,强烈建议星标我们和给我们多点点【在看】。星标具体步骤为:<br data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(53, 53, 53)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(177, 177, 177)" data-darkmode-original-color="rgb(53, 53, 53)">

<br data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)">

(1)点击页面最上方“小詹学Python”,进入公众号主页。

<br data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)">

(2)点击右上角的小点点,在弹出页面点击“设为星标”,就可以啦。

<br data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)">

感谢支持,比心。

</p> 查看全部

c爬虫抓取网页数据(爬虫是Python的一个重要的应用,使用Python爬虫我们可以轻松的从互联网中抓取

)

爬虫是Python的一个重要应用。使用Python爬虫,我们可以很方便的从网上抓取我们想要的数据。本文将以抓取B站视频热搜榜数据并存储为例,详细介绍Python爬虫的基本流程。如果您还处于初始爬虫阶段或者不了解爬虫的具体工作流程,那么您应该仔细阅读本文!

第 1 步:尝试请求

先到b站首页,点击排行榜,复制链接

https://www.bilibili.com/ranki ... 162.3

现在启动 Jupyter notebook 并运行以下代码

import requests

url = 'https://www.bilibili.com/ranking?spm_id_from=333.851.b_7072696d61727950616765546162.3'

res = requests.get('url')

print(res.status_code)

#200

在上面的代码中,我们完成了以下三件事

可以看到返回值为200,说明服务器响应正常,可以继续。

第二步:解析页面

上一步我们通过requests向网站请求数据后,成功获取到一个收录服务器资源的Response对象,现在可以使用.text查看其内容

可以看到返回了一个字符串,里面收录了我们需要的热门视频数据,但是直接从字符串中提取内容比较复杂,效率低下,所以我们需要对其进行解析,将字符串转换成结构化的网页数据,以便您可以轻松找到 HTML 标记及其属性和内容。

在 Python 中有很多方法可以解析网页。您可以使用正则表达式,也可以使用 BeautifulSoup、pyquery 或 lxml。本文将基于 BeautifulSoup 来解释它们。

Beautiful Soup 是一个第三方库,可以从 HTML 或 XML 文件中提取数据。安装也非常简单。使用 pip install bs4 进行安装。让我们用一个简单的例子来说明它是如何工作的

from bs4 import BeautifulSoup

page = requests.get(url)

soup = BeautifulSoup(page.content, 'html.parser')

title = soup.title.text

print(title)

# 热门视频排行榜 - 哔哩哔哩 (゜-゜)つロ 干杯~-bilibili

上面代码中,我们使用bs4中的BeautifulSoup类,将上一步得到的html格式字符串转换为BeautifulSoup对象。注意使用的时候需要开发一个解析器,这里使用的是html.parser。

然后就可以获取其中一个结构化元素及其属性,比如使用soup.title.text获取页面标题,也可以使用soup.body、soup.p等获取任意需要的元素。

第 3 步:提取内容

上面两步我们使用requests向网页请求数据,使用bs4解析页面。现在我们到了最关键的一步:如何从解析后的页面中提取需要的内容。

在 Beautiful Soup 中,我们可以使用 find/find_all 来定位元素,但我更习惯使用 CSS 选择器 .select,因为我们可以像使用 CSS 选择元素一样向下访问 DOM 树。

下面我们用代码来说明如何从解析后的页面中提取B站的热点列表数据。首先,我们需要找到存储数据的标签。在列表页面上按 F12 并按照下面的说明找到它。

可以看到每条视频信息都包裹在class="rank-item"的li标签下,那么代码可以这样写吗?

all_products = []

products = soup.select('li.rank-item')

for product in products:

rank = product.select('div.num')[0].text

name = product.select('div.info > a')[0].text.strip()

play = product.select('span.data-box')[0].text

comment = product.select('span.data-box')[1].text

up = product.select('span.data-box')[2].text

url = product.select('div.info > a')[0].attrs['href']

all_products.append({

"视频排名":rank,

"视频名": name,

"播放量": play,

"弹幕量": comment,

"up主": up,

"视频链接": url

})

上面代码中,我们先使用soup.select('li.rank-item'),然后返回一个收录每个视频信息的列表,然后遍历每个视频信息,依然使用CSS选择器提取我们想要的字段信息以字典的形式存储在开头定义的空列表中。

可以注意到,我使用了多种选择方法来提取元素。这也是select方法的灵活性。有兴趣的读者可自行进一步研究。

第 4 步:存储数据

通过前面三步,我们成功使用requests+bs4从网站中提取出需要的数据,最后只需要将数据写入Excel并保存即可。

如果你对pandas不熟悉,可以使用csv模块来编写。需要注意的是设置了encoding='utf-8-sig',否则会出现中文乱码的问题

import csv

keys = all_products[0].keys()

with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

dict_writer = csv.DictWriter(output_file, keys)

dict_writer.writeheader()

dict_writer.writerows(all_products)

如果你熟悉pandas,你可以轻松地将字典转换为DataFrame,只需一行代码

import pandas as pd

keys = all_products[0].keys()

pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

概括

至此,我们已经成功地使用Python在本地存储了b站的热门视频列表数据。大多数基于请求的爬虫基本上都是按照以上四个步骤进行的。

然而,虽然看起来简单,但在真实场景中的每一步都不是那么容易。从请求数据开始,目标网站有多种形式的反爬和加密,后期解析、提取甚至存储数据的方式也很多。需要进一步探索和学习。

本文选择B站视频热榜正是因为足够简单,希望通过这个案例,让大家了解爬取的基本过程,最后附上完整的代码

import requests

from bs4 import BeautifulSoup

import csv

import pandas as pd

url = 'https://www.bilibili.com/ranking?spm_id_from=333.851.b_7072696d61727950616765546162.3'

page = requests.get(url)

soup = BeautifulSoup(page.content, 'html.parser')

all_products = []

products = soup.select('li.rank-item')

for product in products:

rank = product.select('div.num')[0].text

name = product.select('div.info > a')[0].text.strip()

play = product.select('span.data-box')[0].text

comment = product.select('span.data-box')[1].text

up = product.select('span.data-box')[2].text

url = product.select('div.info > a')[0].attrs['href']

all_products.append({

"视频排名":rank,

"视频名": name,

"播放量": play,

"弹幕量": comment,

"up主": up,

"视频链接": url

})

keys = all_products[0].keys()

with open('B站视频热榜TOP100.csv', 'w', newline='', encoding='utf-8-sig') as output_file:

dict_writer = csv.DictWriter(output_file, keys)

dict_writer.writeheader()

dict_writer.writerows(all_products)

### 使用pandas写入数据

pd.DataFrame(all_products,columns=keys).to_csv('B站视频热榜TOP100.csv', encoding='utf-8-sig')

<p data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-style="letter-spacing: 0.544px; white-space: normal; font-weight: 700; widows: 1; word-spacing: 2px; color: rgb(0, 0, 0); font-family: Optima-Regular, Optima, PingFangSC-light, PingFangTC-light, "PingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif; font-size: 16px; caret-color: rgb(51, 51, 51);" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)" style="letter-spacing: 0.544px;white-space: normal;font-weight: 700;widows: 1;word-spacing: 2px;color: rgb(0, 0, 0);font-family: Optima-Regular, Optima, PingFangSC-light, PingFangTC-light, "PingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 16px;caret-color: rgb(51, 51, 51);"><br mpa-from-tpl="t" data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)">

<p data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-style="letter-spacing: 0.544px; white-space: normal; font-weight: 700; widows: 1; word-spacing: 2px; color: rgb(0, 0, 0); font-family: Optima-Regular, Optima, PingFangSC-light, PingFangTC-light, "PingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif; font-size: 16px; caret-color: rgb(51, 51, 51);" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)" style="letter-spacing: 0.544px;white-space: normal;font-weight: 700;widows: 1;word-spacing: 2px;color: rgb(0, 0, 0);font-family: Optima-Regular, Optima, PingFangSC-light, PingFangTC-light, "PingFang SC", Cambria, Cochin, Georgia, Times, "Times New Roman", serif;font-size: 16px;caret-color: rgb(51, 51, 51);"><br mpa-from-tpl="t" data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)">由于微信平台算法改版,公号内容将不再以时间排序展示,如果大家想第一时间看到我们的推送,强烈建议星标我们和给我们多点点【在看】。星标具体步骤为:<br data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(53, 53, 53)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(177, 177, 177)" data-darkmode-original-color="rgb(53, 53, 53)">

<br data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)">

(1)点击页面最上方“小詹学Python”,进入公众号主页。

<br data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)">

(2)点击右上角的小点点,在弹出页面点击“设为星标”,就可以啦。

<br data-darkmode-bgcolor-16030301765599="rgb(25, 25, 25)" data-darkmode-original-bgcolor-16030301765599="rgb(255, 255, 255)" data-darkmode-color-16030301765599="rgb(163, 163, 163)" data-darkmode-original-color-16030301765599="rgb(0, 0, 0)" data-darkmode-bgcolor="rgb(36, 36, 36)" data-darkmode-original-bgcolor="rgb(255, 255, 255)" data-darkmode-color="rgb(230, 230, 230)" data-darkmode-original-color="rgb(0, 0, 0)">

感谢支持,比心。

</p>

</p> c爬虫抓取网页数据(假设获取的是二进制文件,则可以借鉴如下方法保存数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2021-11-24 18:09

一种。假设获取的二进制文件是二进制文件,可以使用以下方法保存数据:

import requests

r = requests.get('https://www.baidu.com/img/bd_logo1.png')

with open('baidu.png', 'wb') as fp:

fp.write(r.content)

湾 为了反爬,一些网站会检测到Headers的User-Agent,需要把headers信息传递给get函数的headers参数。比如知乎,直接访问会返回400,加上 headers 参数可以正确返回:

>>> re = requests.get('https://www.zhihu.com')

>>> re.status_code

400

# headers可从http测试网站https://httpbin.org或浏览器的“开发者工具”获得

>>> headers = {"User-Agent": "Mozilla/5.0 (X11; Linux i686) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.83 Safari/535.11"}

>>> re = requests.get('https://www.zhihu.com', headers = headers)

>>> re.status_code

200

防爬的策略有很多,需要慢慢熟悉。有的网站想要获取数据也需要登录,需要分析登录需要的属性。

C。获取JS渲染的页面内容

有时很难通过浏览器的“开发者工具”功能找到实际提供数据的页面。 查看全部

c爬虫抓取网页数据(假设获取的是二进制文件,则可以借鉴如下方法保存数据)

一种。假设获取的二进制文件是二进制文件,可以使用以下方法保存数据:

import requests

r = requests.get('https://www.baidu.com/img/bd_logo1.png')

with open('baidu.png', 'wb') as fp:

fp.write(r.content)

湾 为了反爬,一些网站会检测到Headers的User-Agent,需要把headers信息传递给get函数的headers参数。比如知乎,直接访问会返回400,加上 headers 参数可以正确返回:

>>> re = requests.get('https://www.zhihu.com')

>>> re.status_code

400

# headers可从http测试网站https://httpbin.org或浏览器的“开发者工具”获得

>>> headers = {"User-Agent": "Mozilla/5.0 (X11; Linux i686) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.83 Safari/535.11"}

>>> re = requests.get('https://www.zhihu.com', headers = headers)

>>> re.status_code

200

防爬的策略有很多,需要慢慢熟悉。有的网站想要获取数据也需要登录,需要分析登录需要的属性。

C。获取JS渲染的页面内容

有时很难通过浏览器的“开发者工具”功能找到实际提供数据的页面。

c爬虫抓取网页数据(大数据为各行各业提供数据支撑到底会不会入狱(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-11-22 11:12

文章内容

前言

在今天的大数据时代,程序的运行和人工智能的训练都离不开海量数据的需求,而目前(贵阳大数据交易所)等大数据交易平台最不能满足我们的数据需求当时间,或者说购买数据的消耗大于聘请爬虫工程师时,公司会聘请爬虫工程师开发爬虫程序,对公司需要的数据进行爬取。接下来我们来说说爬虫会不会坐牢。

当前状态

目前,由于大数据时代的井喷式发展,数据的规模越来越大,我们对海量数据的依赖也是必不可少的。大数据为各行各业(电子商务、旅游、娱乐、社交网络等)提供数据支持。这些数据为我们提供了大量便捷的服务。同时,我们也成为了“贡献者”,免费贡献自己的行踪和个人信息。、网站或者app通过后台获取了我们的一些个人信息,比如手机号码、姓名、购物爱好、旅游爱好、经常去的地方、娱乐爱好等。通过这些小数据,很多东西都可以分析和绘制消费者画像等,例如在您观看小视频时,你会发现你看到的大部分数据都是你在购物的时候经常浏览的。这是由网站通过留下的访问信息完成的。“精准推送”。随着时间的推移和技术的发展,我们对数据的需求会越来越大,这对于爬虫行业的从业者来说也是一个很大的机会。

爬虫定义

首先我们要知道什么是网络爬虫

网络爬虫是指按照一定的规则自动抓取网络信息的程序或脚本。简单来说,就是使用某种编程语言(c语言、python、java)基于某种算法开发的一种网络爬虫,主要是通过URL程序代码进行数据的抓取和挖掘

爬虫在我们的日常生活中无处不在,但我们却找不到它们。传统爬虫包括百度、谷歌、必应、360等搜索引擎。这些都是一般的爬虫,都有一定的局限性。这导致了我们。使用不同的浏览器搜索相同的东西会导致不同的结果。出现这种情况。因为一般的爬虫程序很多时候无法准确获取到我们想要的数据,所以有聚焦爬虫、增量爬虫、深度网络爬虫。详细情况如下

履带分类

万能爬虫

一般爬虫也称为全网爬虫。一般爬虫爬取的数据范围和数据量都很大,通常每次都会得到海量的数据。由于爬取的数据量过大,一般爬虫的速度很慢,也很准确。性也不尽如人意。对于百度,我们经常在浏览器中搜索数据,并不能很好地找到我们想要的数据,这不符合我们公司对准确数据的要求。

搜索结果第一行下方的百度快照是百度蜘蛛抓取的数据,显示在我们的百度搜索结果页面

专注履带

重点爬虫就是使用设置的爬虫规则对指定的数据进行爬取。它不会针对整个网络。它只会针对我们指定的网页或其他地方来抓取我们指定的数据。提取数据进行存储

增量爬虫

增量爬虫就是爬取网络更新的数据来更新我们已经爬取的数据

深度网络爬虫

顾名思义,就是访问更深的东西。深层数据通常是表面页面数据的数倍,即深层网络爬虫抓取的对象。

原则

简单来说,爬虫程序就是不断地向服务器发出请求,获取数据,解析数据,提取数据,设置停止条件。如果爬虫不设置条件,就会变成爬虫“僵尸”,无休止地请求网页爬取数据。

通常,爬虫程序在爬取数据时发起的数据请求量很大。一秒钟内可以发送数十个或数百个数据访问请求。当我们的程序大量运行时,对于一些小的网站来说是一个巨大的负担,可能导致服务器瘫痪、宏机等。

我们在抓取数据时,无法抓取某些网页数据,如用户个人隐私信息、企业机密信息等,我们抓取这些数据是违法的。下面是机器人协议。接下来我们将介绍robots协议

机器人自述文件

robots协议也叫robots.txt(统一小写),是存放在网站根目录下的ASCII编码文本文件。它通常告诉网络搜索引擎的机器人(也称为网络蜘蛛)这个网站@中的哪些内容不应该被搜索引擎机器人获取,哪些内容可以被机器人获取。由于某些系统中的URL 区分大小写,因此robots.txt 的文件名应统一小写。robots.txt应该放在网站的根目录下。如果你想单独定义搜索引擎robots访问子目录时的行为,你可以将你的自定义设置合并到根目录下的robots.txt中,或者使用robots metadata(Metadata,也称为metadata)。

robots协议不是规范,而是约定,所以不保证网站的隐私。机器人协议产生了另一个名称“君子协议”

如果把网站当成酒店的房间,robots.txt就是房主挂在房间门口的“请勿打扰”或“欢迎打扫”的牌子。这份文件告诉来访搜索引擎哪些房间可以进入和访问,哪些房间因为存放贵重物品,或者可能涉及到住户和来访者的隐私,所以不向搜索引擎开放。但是robots.txt不是命令,也不是防火墙,就像看门人无法阻止小偷等恶意入侵者一样。

机器人协议视图

说了这么多,那我们怎么知道网站中是否有robots.txt文件呢?那些东西可以爬。我们在爬取一个网站的时候,首先会检查是否有robots.txt文件。如果存在,我们会检查网站允许我们爬取的那些东西,我们的爬虫程序会根据相关的爬取范围来爬取数据,有些网站没有创建robots.txt文件,不代表我们可以肆无忌惮的爬取数据,爬取数据时仍然存在一定的违法风险

网页链接后添加robots.txt即可查看robots协议

以上是天猫的网页地址。通过在后面添加robots.txt并回车,我们将跳转到robots文件页面。

以下是跳转后出现的robots文件

User-agent: *

Disallow: /

User-agent 描述了搜索爬虫的名称。这里的*号是指对所有爬虫都有效。如果以下是baiduspider,则该规则对百度有效

Disallow 指定不允许爬取的目录,设置/表示不允许爬取所有页面

上面天猫的robots不允许所有爬虫访问所有目录,下图是允许所有爬虫访问所有目录

User-agent: *

Disallow:

常用爬虫名 爬虫名名网站

百度蜘蛛(Baidu Spider)

百度

谷歌机器人(谷歌蜘蛛)

谷歌

360蜘蛛(360蜘蛛)

360

Bingbot(必应蜘蛛)

必须

雅虎!啜饮中国

雅虎中国

YoudaoBot(有道蜘蛛)

有道

一搜蜘蛛

神马搜索

网络爬虫规定

网信委关于网络爬虫的法律规定]()

管制区

一.恶意抓拍侵犯他人权益和操作自由。通过网络爬虫访问和采集网站数据行为本身就产生了相当大的网络流量。不正当手段会帮助不法组织造假网站,造成欺诈风险,窃取知识产权和商业秘密。

二.对目标的DDOS攻击网站导致大量时间和金钱损失

三.个人隐私数据的获取和销售

爬虫非法案例

【2019年人民法院十大刑事案件】全国首起“爬虫技术”犯罪案件

大众点评诉百度不正当竞争案开庭

“车来了”被警方以涉嫌窃取数据立案,进入非法获取计算机系统数据案 查看全部

c爬虫抓取网页数据(大数据为各行各业提供数据支撑到底会不会入狱(组图))

文章内容

前言

在今天的大数据时代,程序的运行和人工智能的训练都离不开海量数据的需求,而目前(贵阳大数据交易所)等大数据交易平台最不能满足我们的数据需求当时间,或者说购买数据的消耗大于聘请爬虫工程师时,公司会聘请爬虫工程师开发爬虫程序,对公司需要的数据进行爬取。接下来我们来说说爬虫会不会坐牢。

当前状态

目前,由于大数据时代的井喷式发展,数据的规模越来越大,我们对海量数据的依赖也是必不可少的。大数据为各行各业(电子商务、旅游、娱乐、社交网络等)提供数据支持。这些数据为我们提供了大量便捷的服务。同时,我们也成为了“贡献者”,免费贡献自己的行踪和个人信息。、网站或者app通过后台获取了我们的一些个人信息,比如手机号码、姓名、购物爱好、旅游爱好、经常去的地方、娱乐爱好等。通过这些小数据,很多东西都可以分析和绘制消费者画像等,例如在您观看小视频时,你会发现你看到的大部分数据都是你在购物的时候经常浏览的。这是由网站通过留下的访问信息完成的。“精准推送”。随着时间的推移和技术的发展,我们对数据的需求会越来越大,这对于爬虫行业的从业者来说也是一个很大的机会。

爬虫定义

首先我们要知道什么是网络爬虫

网络爬虫是指按照一定的规则自动抓取网络信息的程序或脚本。简单来说,就是使用某种编程语言(c语言、python、java)基于某种算法开发的一种网络爬虫,主要是通过URL程序代码进行数据的抓取和挖掘

爬虫在我们的日常生活中无处不在,但我们却找不到它们。传统爬虫包括百度、谷歌、必应、360等搜索引擎。这些都是一般的爬虫,都有一定的局限性。这导致了我们。使用不同的浏览器搜索相同的东西会导致不同的结果。出现这种情况。因为一般的爬虫程序很多时候无法准确获取到我们想要的数据,所以有聚焦爬虫、增量爬虫、深度网络爬虫。详细情况如下

履带分类

万能爬虫

一般爬虫也称为全网爬虫。一般爬虫爬取的数据范围和数据量都很大,通常每次都会得到海量的数据。由于爬取的数据量过大,一般爬虫的速度很慢,也很准确。性也不尽如人意。对于百度,我们经常在浏览器中搜索数据,并不能很好地找到我们想要的数据,这不符合我们公司对准确数据的要求。

搜索结果第一行下方的百度快照是百度蜘蛛抓取的数据,显示在我们的百度搜索结果页面

专注履带

重点爬虫就是使用设置的爬虫规则对指定的数据进行爬取。它不会针对整个网络。它只会针对我们指定的网页或其他地方来抓取我们指定的数据。提取数据进行存储

增量爬虫

增量爬虫就是爬取网络更新的数据来更新我们已经爬取的数据

深度网络爬虫

顾名思义,就是访问更深的东西。深层数据通常是表面页面数据的数倍,即深层网络爬虫抓取的对象。

原则

简单来说,爬虫程序就是不断地向服务器发出请求,获取数据,解析数据,提取数据,设置停止条件。如果爬虫不设置条件,就会变成爬虫“僵尸”,无休止地请求网页爬取数据。

通常,爬虫程序在爬取数据时发起的数据请求量很大。一秒钟内可以发送数十个或数百个数据访问请求。当我们的程序大量运行时,对于一些小的网站来说是一个巨大的负担,可能导致服务器瘫痪、宏机等。

我们在抓取数据时,无法抓取某些网页数据,如用户个人隐私信息、企业机密信息等,我们抓取这些数据是违法的。下面是机器人协议。接下来我们将介绍robots协议

机器人自述文件

robots协议也叫robots.txt(统一小写),是存放在网站根目录下的ASCII编码文本文件。它通常告诉网络搜索引擎的机器人(也称为网络蜘蛛)这个网站@中的哪些内容不应该被搜索引擎机器人获取,哪些内容可以被机器人获取。由于某些系统中的URL 区分大小写,因此robots.txt 的文件名应统一小写。robots.txt应该放在网站的根目录下。如果你想单独定义搜索引擎robots访问子目录时的行为,你可以将你的自定义设置合并到根目录下的robots.txt中,或者使用robots metadata(Metadata,也称为metadata)。

robots协议不是规范,而是约定,所以不保证网站的隐私。机器人协议产生了另一个名称“君子协议”

如果把网站当成酒店的房间,robots.txt就是房主挂在房间门口的“请勿打扰”或“欢迎打扫”的牌子。这份文件告诉来访搜索引擎哪些房间可以进入和访问,哪些房间因为存放贵重物品,或者可能涉及到住户和来访者的隐私,所以不向搜索引擎开放。但是robots.txt不是命令,也不是防火墙,就像看门人无法阻止小偷等恶意入侵者一样。

机器人协议视图

说了这么多,那我们怎么知道网站中是否有robots.txt文件呢?那些东西可以爬。我们在爬取一个网站的时候,首先会检查是否有robots.txt文件。如果存在,我们会检查网站允许我们爬取的那些东西,我们的爬虫程序会根据相关的爬取范围来爬取数据,有些网站没有创建robots.txt文件,不代表我们可以肆无忌惮的爬取数据,爬取数据时仍然存在一定的违法风险

网页链接后添加robots.txt即可查看robots协议

以上是天猫的网页地址。通过在后面添加robots.txt并回车,我们将跳转到robots文件页面。

以下是跳转后出现的robots文件

User-agent: *

Disallow: /

User-agent 描述了搜索爬虫的名称。这里的*号是指对所有爬虫都有效。如果以下是baiduspider,则该规则对百度有效

Disallow 指定不允许爬取的目录,设置/表示不允许爬取所有页面

上面天猫的robots不允许所有爬虫访问所有目录,下图是允许所有爬虫访问所有目录

User-agent: *

Disallow:

常用爬虫名 爬虫名名网站

百度蜘蛛(Baidu Spider)

百度

谷歌机器人(谷歌蜘蛛)

谷歌

360蜘蛛(360蜘蛛)

360

Bingbot(必应蜘蛛)

必须

雅虎!啜饮中国

雅虎中国

YoudaoBot(有道蜘蛛)

有道

一搜蜘蛛

神马搜索

网络爬虫规定

网信委关于网络爬虫的法律规定]()

管制区

一.恶意抓拍侵犯他人权益和操作自由。通过网络爬虫访问和采集网站数据行为本身就产生了相当大的网络流量。不正当手段会帮助不法组织造假网站,造成欺诈风险,窃取知识产权和商业秘密。

二.对目标的DDOS攻击网站导致大量时间和金钱损失

三.个人隐私数据的获取和销售

爬虫非法案例

【2019年人民法院十大刑事案件】全国首起“爬虫技术”犯罪案件

大众点评诉百度不正当竞争案开庭

“车来了”被警方以涉嫌窃取数据立案,进入非法获取计算机系统数据案

c爬虫抓取网页数据(一个通用的网络爬虫的基本结构及工作流程(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-11-22 11:12

网络爬虫是搜索引擎爬虫系统的重要组成部分。爬虫的主要目的是将互联网上的网页下载到本地,形成网络内容的镜像备份。本篇博客主要是对爬虫和爬虫系统的简要介绍。

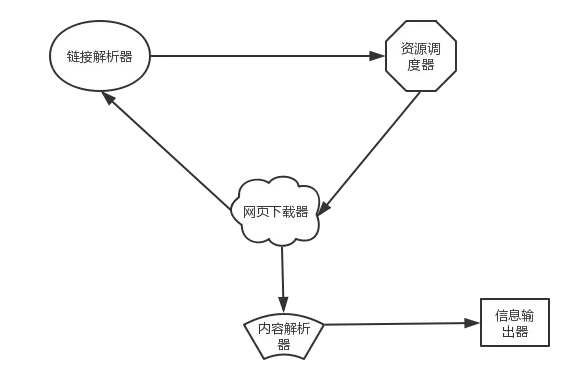

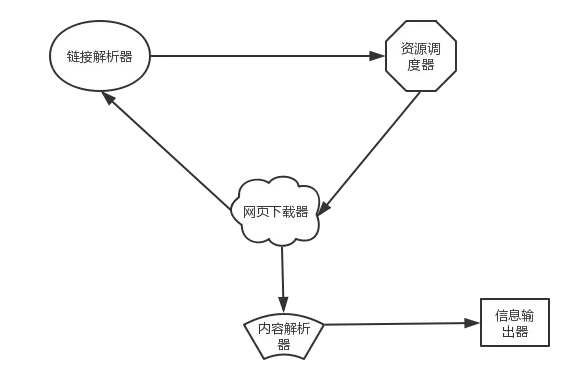

一、网络爬虫的基本结构和工作流程

一个通用的网络爬虫的框架如图所示:

网络爬虫的基本工作流程如下:

1.首先选择一些精心挑选的种子网址;

2.将这些URL放入URL队列进行抓取;

3. 从待爬取的URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,并保存到下载的网页库中。另外,将这些网址放入已爬取的网址队列中。

4.对爬取的URL队列中的URL进行分析,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

二、从爬虫的角度划分互联网

相应地,互联网的所有页面可以分为五个部分:

1.下载了未过期的网页

2.已下载并过期的网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态变化的,互联网上的一些内容已经发生了变化。此时,这部分爬取到的页面已经过期。

3.要下载的页面:URL队列中要爬取的那些页面

4. 可识网页:尚未被抓取,也不在待抓取的URL队列中,但通过分析抓取的页面或待抓取的URL对应的页面得到的URL,被认为是一个已知网页。

5.还有一些网页是爬虫无法直接抓取下载的。它被称为不可知页面。

三、抓取策略

在爬虫系统中,要爬取的URL队列是一个非常重要的部分。URL队列中要爬取的URL的顺序也是一个很重要的问题,因为它涉及到先爬哪个页面,后爬哪个页面。确定这些 URL 顺序的方法称为抓取策略。下面重点介绍几种常见的爬取策略:

1.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,逐个跟踪每一个链接,处理完这一行后转移到下一个起始页,继续跟踪链接。我们以下图为例:

遍历的路径:AFG EHI BCD

2.宽度优先遍历策略

广度优先遍历策略的基本思想是将新下载的网页中找到的链接直接插入到待爬取的URL队列的末尾。即网络爬虫会先抓取起始网页中所有链接的网页,然后选择其中一个链接的网页,继续抓取该网页中链接的所有网页。以上图为例:

遍历路径:ABCDEF GHI

3.反向链接计数策略

反向链接数是指从其他网页链接到某个网页的数量。反向链接的数量表示网页内容被他人推荐的程度。因此,很多时候搜索引擎的爬取系统都会使用这个指标来评估网页的重要性,从而决定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量不能完全坐等别人的重视。因此,搜索引擎通常会考虑一些可靠的反向链接。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,连同要爬取的URL队列中的URL,形成一个网页集合,计算每个页面的PageRank值,计算后完成后,将要抓取的 URL 队列中的 URL 按照 PageRank 值的大小进行排列,并按此顺序抓取页面。

如果每个页面都被抓取,则重新计算 PageRank 值。一个折衷的方案是:每爬取K个页面后,重新计算PageRank值。但是,这种情况下仍然存在一个问题:对于已经从下载页面中分析出来的链接,也就是我们前面提到的未知网页部分,暂时没有PageRank值。为了解决这个问题,这些页面会被赋予一个临时的PageRank值:将所有传入该页面链的PageRank值汇总,从而形成未知页面的PageRank值参与排名。以下示例说明:

5.OPIC 策略

该算法实际上对页面的重要性进行评分。在算法开始之前,给所有页面相同的初始现金(cash)。下载某个页面P后,将P的现金分配给所有从P解析的链接,清空P的现金。待抓取的 URL 队列中的所有页面均按照现金的数量进行排序。

6.大站优先策略

待爬取的 URL 队列中的所有网页都按照其所属的 网站 进行分类。网站需要下载的页面较多,优先下载。这种策略因此被称为大站优先策略。

参考书目:

1. 《这是搜索引擎-核心技术详解》张俊林电子工业出版社

2. 《搜索引擎技术基础》刘义群等清华大学出版社 查看全部

c爬虫抓取网页数据(一个通用的网络爬虫的基本结构及工作流程(组图))

网络爬虫是搜索引擎爬虫系统的重要组成部分。爬虫的主要目的是将互联网上的网页下载到本地,形成网络内容的镜像备份。本篇博客主要是对爬虫和爬虫系统的简要介绍。

一、网络爬虫的基本结构和工作流程

一个通用的网络爬虫的框架如图所示:

网络爬虫的基本工作流程如下:

1.首先选择一些精心挑选的种子网址;

2.将这些URL放入URL队列进行抓取;

3. 从待爬取的URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,并保存到下载的网页库中。另外,将这些网址放入已爬取的网址队列中。

4.对爬取的URL队列中的URL进行分析,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

二、从爬虫的角度划分互联网

相应地,互联网的所有页面可以分为五个部分:

1.下载了未过期的网页

2.已下载并过期的网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态变化的,互联网上的一些内容已经发生了变化。此时,这部分爬取到的页面已经过期。

3.要下载的页面:URL队列中要爬取的那些页面

4. 可识网页:尚未被抓取,也不在待抓取的URL队列中,但通过分析抓取的页面或待抓取的URL对应的页面得到的URL,被认为是一个已知网页。

5.还有一些网页是爬虫无法直接抓取下载的。它被称为不可知页面。

三、抓取策略

在爬虫系统中,要爬取的URL队列是一个非常重要的部分。URL队列中要爬取的URL的顺序也是一个很重要的问题,因为它涉及到先爬哪个页面,后爬哪个页面。确定这些 URL 顺序的方法称为抓取策略。下面重点介绍几种常见的爬取策略:

1.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,逐个跟踪每一个链接,处理完这一行后转移到下一个起始页,继续跟踪链接。我们以下图为例:

遍历的路径:AFG EHI BCD

2.宽度优先遍历策略

广度优先遍历策略的基本思想是将新下载的网页中找到的链接直接插入到待爬取的URL队列的末尾。即网络爬虫会先抓取起始网页中所有链接的网页,然后选择其中一个链接的网页,继续抓取该网页中链接的所有网页。以上图为例:

遍历路径:ABCDEF GHI

3.反向链接计数策略

反向链接数是指从其他网页链接到某个网页的数量。反向链接的数量表示网页内容被他人推荐的程度。因此,很多时候搜索引擎的爬取系统都会使用这个指标来评估网页的重要性,从而决定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量不能完全坐等别人的重视。因此,搜索引擎通常会考虑一些可靠的反向链接。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,连同要爬取的URL队列中的URL,形成一个网页集合,计算每个页面的PageRank值,计算后完成后,将要抓取的 URL 队列中的 URL 按照 PageRank 值的大小进行排列,并按此顺序抓取页面。

如果每个页面都被抓取,则重新计算 PageRank 值。一个折衷的方案是:每爬取K个页面后,重新计算PageRank值。但是,这种情况下仍然存在一个问题:对于已经从下载页面中分析出来的链接,也就是我们前面提到的未知网页部分,暂时没有PageRank值。为了解决这个问题,这些页面会被赋予一个临时的PageRank值:将所有传入该页面链的PageRank值汇总,从而形成未知页面的PageRank值参与排名。以下示例说明:

5.OPIC 策略

该算法实际上对页面的重要性进行评分。在算法开始之前,给所有页面相同的初始现金(cash)。下载某个页面P后,将P的现金分配给所有从P解析的链接,清空P的现金。待抓取的 URL 队列中的所有页面均按照现金的数量进行排序。

6.大站优先策略

待爬取的 URL 队列中的所有网页都按照其所属的 网站 进行分类。网站需要下载的页面较多,优先下载。这种策略因此被称为大站优先策略。

参考书目:

1. 《这是搜索引擎-核心技术详解》张俊林电子工业出版社

2. 《搜索引擎技术基础》刘义群等清华大学出版社

c爬虫抓取网页数据(Content-Type:翻页、限制怎么处理?多级分类数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-11-20 16:24

内容类型:多部分/表单数据;边界=----WebKitFormBoundaryA

------WebKitFormBoundaryA

内容配置:表单数据;

标题

------WebKitFormBoundaryA

内容配置:表单数据;;文件名=“铬.png”

内容类型:图像/png

二进制文件内容...

------WebKitFormBoundaryA--

以上部分是发送格式,WebKitFormBoundaryA 可以使用任何内容,只要是这种格式即可。常见的内容类型是 application/x-www-form-urlencoded、application/json、text/xml。

16、如何处理翻页限制?

很多多级分类数据都有翻页限制,分类只显示前几页。在这种情况下,您可以使用这种网站 过滤功能,例如按时间顺序、大小和排序来扩展页面内容。如果有子类,继续获取子类。如果有多个选项,可以通过排列组合,得到尽可能多的选项。

17、 海量网址重复重复怎么办?

如果数据量不大,可以md5 URL,然后用hash进行比较。如果是大量的URL重复,可以使用Bloom filter算法BloomFilter。

18、如何提高爬行速度

1)使用gzip/deflate压缩,一般可以压缩到原来大小的20%左右。一般情况下,服务器不会给你发送压缩数据,你需要发送 Accept-encoding 头。

2) 要使用链接池,需要在C#请求时将keep-alive设置为true。

3) 设置超时,果断关闭一直无响应的请求。

19、抓取收录特定关键词的网页

使用站点搜索,搜索引擎站点,下载所有

20、CSS/HTML 混淆干扰受限数据获取

常见的此类防攀爬方法有

1)用图片替换一些文字

2)使用自定义字体

3)伪元素隐藏

4) 元素位置关闭

其中,第一种情况,可以找到图片对应的文字,全部找到后替换。二是找到ttf字体文件地址并下载,然后找到代码和文字的对应关系并替换。三是查找class对应的文本内容进行替换。第四类涉及计算。如果觉得麻烦,也可以截图来识别。

21、 数据抓取过程中发现电信劫持,导致数据错误怎么办?

通过电话向电信运营商投诉,您可以通过电话或工业和信息化部进行投诉。

有时计算机中的病毒也有这种劫持,属于黑产方面。

22、关于eval(function(p,a,c,k,e,d)加密

这是一种经典的数据加密方式,网上已经有了在线的加解密方式。在本地运行时,需要使用JS引擎执行js才能得到结果。

23、PKI证书验证如何处理网站?

PKI证书一般用于登录时请求并上传证书到特定地址进行验证,验证后生成带参数的URL返回网站,生成cookie完成身份验证。也有实现验证的插件,比如吉大正元。

24、HtmlAgilityPack 解析网页时要注意什么

在很久以前的版本中,HtmlAgilityPack 有一个溢出漏洞,即节点分析会陷入死循环。新版本解决了这个问题,请使用最新版本。使用 HtmlAgilityPack 解析网页时,需要注意它可能会因为页面错误而无法解析。可以先用replacement等方法对源码进行处理,再进行分析。

25、 除了fiddler还有哪些抓包工具?

1)微软网络监视器

2)Wireshark

3)Anyproxy

26、 抓到的数据不全怎么办?

有些网站只会对外展示部分数据,或者只展示部分用户的全部数据。在这种情况下,观察能力就是一种考验。比如很久以前同城的网站的联系方式只显示了前7位,而在另一个地方却显示了后4位,所以抓起来加起来就行了。还有一些网站,使用json调用api。一看就知道程序员用的是select *。返回的数据收录了所有相关和不相关的数据,相当于一个明显的漏洞。有时候也可以用不完整的资料,然后去网站搜索一下,说不定会有新的发现。

27、网站 CDN反爬虫如何处理?

网站使用cdn技术可以提高访问速度和安全性,并提供更高的反爬虫能力。但是有的网站会暴露真实的服务器地址,无法确定CDN的来源,导致假CDN服务器能够持续抓取数据。同时,大部分CDN服务器没有反爬虫联动,导致CDN服务器增多,相当于为爬虫提供了更多的代理服务器。

28、使用Xpath获取网页元素需要注意什么?

浏览器渲染后,再用xpath提取Dom元素,然后取值,是一种可以忽略渲染过程,实时获取最新数据的方法。设置xpath抽取规则时,要善于使用绝对相对、收录、或、等符号,尽快定位元素。如果最终元素符号不确定,则可以使用父定位。尽可能使用@id 作为唯一标识符。

29、遇到网站中毒怎么办?

当遇到目标网站时,检测到一个爬虫,给出错误的数据,因为无法直接判断数据的准确性,最终的结果只能通过多种或多种形式的爬取来获得。通过比较,如果多次正确,就可以认为是正确的数据。这种思维可以用在类似的情况下。比如使用下载软件下载资源时,经常会出现无法下载的情况。如果同时搜索一个资源的多个下载链接并同时下载,可以快速过滤掉可下载的。

30、待续。. . 对于新问题,您可以发送电子邮件至 查看全部

c爬虫抓取网页数据(Content-Type:翻页、限制怎么处理?多级分类数据)

内容类型:多部分/表单数据;边界=----WebKitFormBoundaryA

------WebKitFormBoundaryA

内容配置:表单数据;

标题

------WebKitFormBoundaryA

内容配置:表单数据;;文件名=“铬.png”

内容类型:图像/png

二进制文件内容...

------WebKitFormBoundaryA--

以上部分是发送格式,WebKitFormBoundaryA 可以使用任何内容,只要是这种格式即可。常见的内容类型是 application/x-www-form-urlencoded、application/json、text/xml。

16、如何处理翻页限制?

很多多级分类数据都有翻页限制,分类只显示前几页。在这种情况下,您可以使用这种网站 过滤功能,例如按时间顺序、大小和排序来扩展页面内容。如果有子类,继续获取子类。如果有多个选项,可以通过排列组合,得到尽可能多的选项。

17、 海量网址重复重复怎么办?

如果数据量不大,可以md5 URL,然后用hash进行比较。如果是大量的URL重复,可以使用Bloom filter算法BloomFilter。

18、如何提高爬行速度

1)使用gzip/deflate压缩,一般可以压缩到原来大小的20%左右。一般情况下,服务器不会给你发送压缩数据,你需要发送 Accept-encoding 头。

2) 要使用链接池,需要在C#请求时将keep-alive设置为true。

3) 设置超时,果断关闭一直无响应的请求。

19、抓取收录特定关键词的网页

使用站点搜索,搜索引擎站点,下载所有

20、CSS/HTML 混淆干扰受限数据获取

常见的此类防攀爬方法有

1)用图片替换一些文字

2)使用自定义字体

3)伪元素隐藏

4) 元素位置关闭

其中,第一种情况,可以找到图片对应的文字,全部找到后替换。二是找到ttf字体文件地址并下载,然后找到代码和文字的对应关系并替换。三是查找class对应的文本内容进行替换。第四类涉及计算。如果觉得麻烦,也可以截图来识别。

21、 数据抓取过程中发现电信劫持,导致数据错误怎么办?

通过电话向电信运营商投诉,您可以通过电话或工业和信息化部进行投诉。

有时计算机中的病毒也有这种劫持,属于黑产方面。

22、关于eval(function(p,a,c,k,e,d)加密

这是一种经典的数据加密方式,网上已经有了在线的加解密方式。在本地运行时,需要使用JS引擎执行js才能得到结果。

23、PKI证书验证如何处理网站?

PKI证书一般用于登录时请求并上传证书到特定地址进行验证,验证后生成带参数的URL返回网站,生成cookie完成身份验证。也有实现验证的插件,比如吉大正元。

24、HtmlAgilityPack 解析网页时要注意什么

在很久以前的版本中,HtmlAgilityPack 有一个溢出漏洞,即节点分析会陷入死循环。新版本解决了这个问题,请使用最新版本。使用 HtmlAgilityPack 解析网页时,需要注意它可能会因为页面错误而无法解析。可以先用replacement等方法对源码进行处理,再进行分析。

25、 除了fiddler还有哪些抓包工具?

1)微软网络监视器

2)Wireshark

3)Anyproxy

26、 抓到的数据不全怎么办?

有些网站只会对外展示部分数据,或者只展示部分用户的全部数据。在这种情况下,观察能力就是一种考验。比如很久以前同城的网站的联系方式只显示了前7位,而在另一个地方却显示了后4位,所以抓起来加起来就行了。还有一些网站,使用json调用api。一看就知道程序员用的是select *。返回的数据收录了所有相关和不相关的数据,相当于一个明显的漏洞。有时候也可以用不完整的资料,然后去网站搜索一下,说不定会有新的发现。

27、网站 CDN反爬虫如何处理?

网站使用cdn技术可以提高访问速度和安全性,并提供更高的反爬虫能力。但是有的网站会暴露真实的服务器地址,无法确定CDN的来源,导致假CDN服务器能够持续抓取数据。同时,大部分CDN服务器没有反爬虫联动,导致CDN服务器增多,相当于为爬虫提供了更多的代理服务器。

28、使用Xpath获取网页元素需要注意什么?

浏览器渲染后,再用xpath提取Dom元素,然后取值,是一种可以忽略渲染过程,实时获取最新数据的方法。设置xpath抽取规则时,要善于使用绝对相对、收录、或、等符号,尽快定位元素。如果最终元素符号不确定,则可以使用父定位。尽可能使用@id 作为唯一标识符。

29、遇到网站中毒怎么办?

当遇到目标网站时,检测到一个爬虫,给出错误的数据,因为无法直接判断数据的准确性,最终的结果只能通过多种或多种形式的爬取来获得。通过比较,如果多次正确,就可以认为是正确的数据。这种思维可以用在类似的情况下。比如使用下载软件下载资源时,经常会出现无法下载的情况。如果同时搜索一个资源的多个下载链接并同时下载,可以快速过滤掉可下载的。

30、待续。. . 对于新问题,您可以发送电子邮件至

c爬虫抓取网页数据(博客地址:Python入门(一)(图):爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-11-20 04:00

题外话

我第一次听说 Python 是在我大二的时候。当时我没有学好C语言,所以不想学其他的编程语言。现在,我想在我的毕业项目中使用爬虫技术。上网查了一下,Python语言的爬虫技术得到了一致好评。

于是从昨天开始,在网上搜索了各种Python爬虫小程序的源码,可是一天过去了,不仅没有写出简单的爬虫程序,反而对Python应该编写的各种包和语法越来越糊涂了介绍。去菜鸟教程,Python语言比较复杂(虽然它的语法很简单,但是对于初学者来说,很多东西封装在一个包里是很陌生的),自己补了Python语法,然后开始搜索各种教程在网上,总之,我把别人写的爬虫入门级的程序都打出来了,但都没有奏效,还出现各种错误。

然而,我今天找到了一个博客。博主仔细讲了最简单的爬虫步骤,用到了哪些包,源代码也是逐句分析的,于是我的第一个爬虫程序就成功了。分享一下这位博主的博客,写下我的感受。

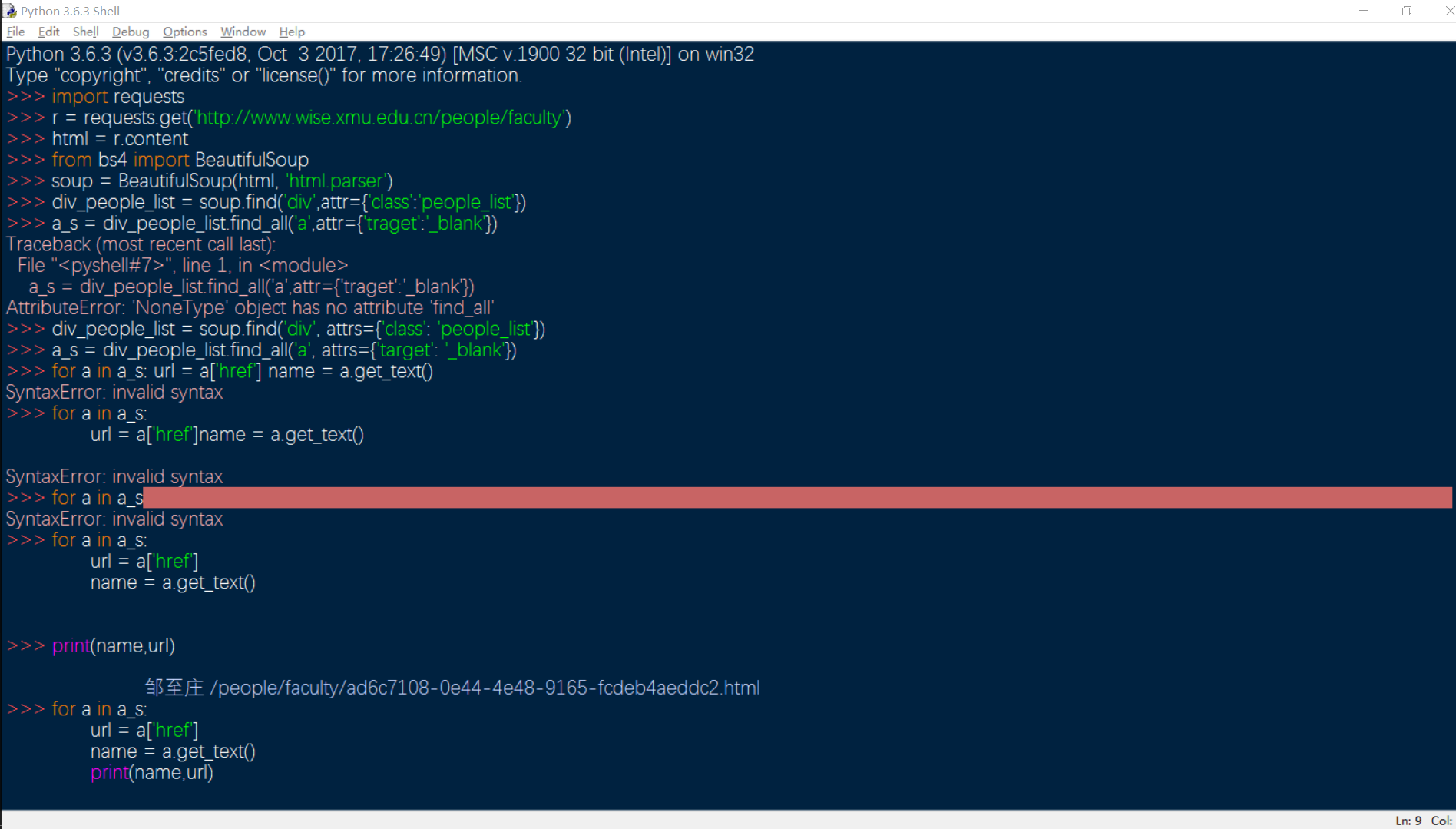

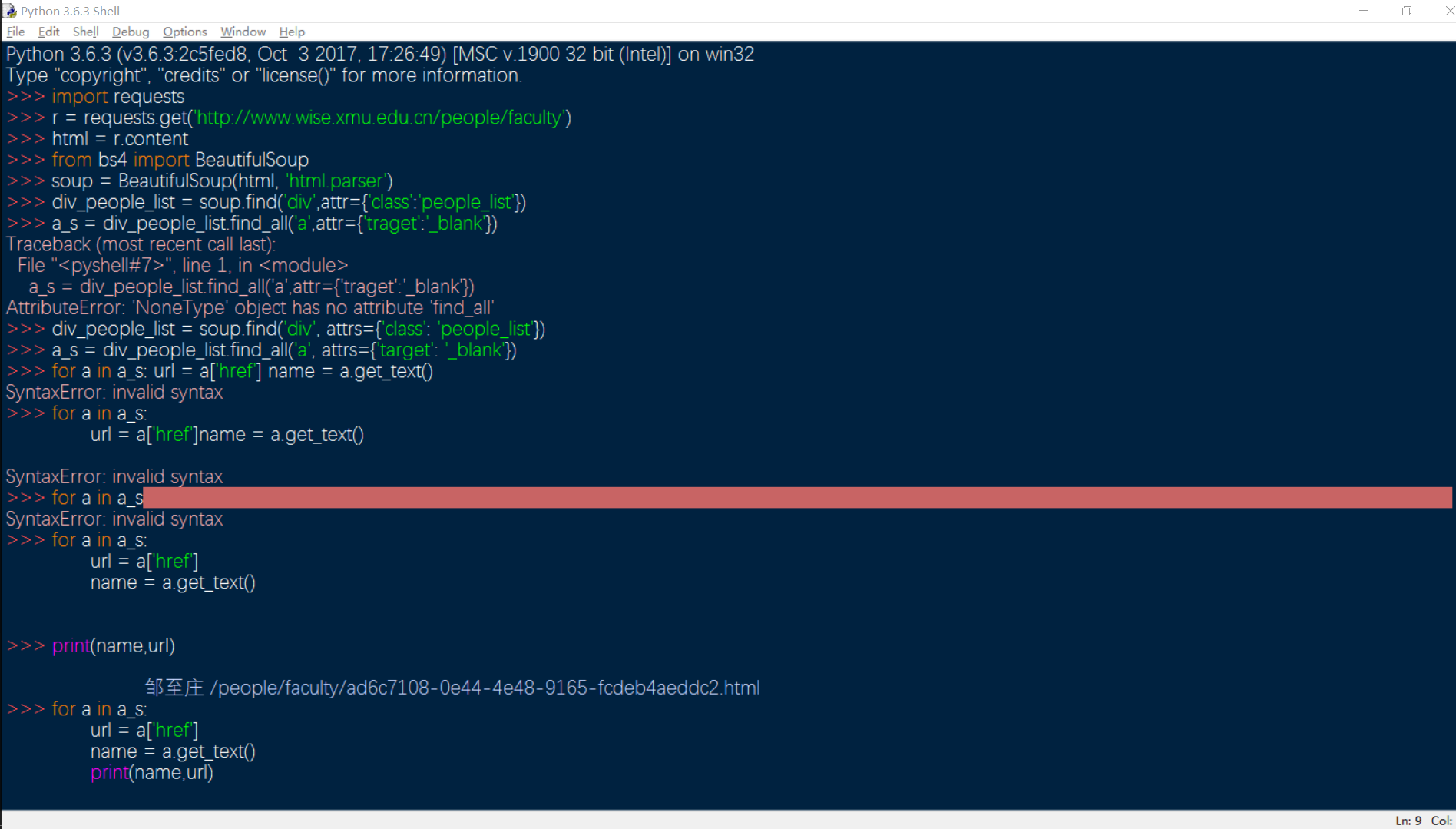

博客地址:Python入门(一):爬虫基本结构&简单例子。

我的实践

下图是我按照博主的代码得到的结果。虽然过程中出现了一点语法错误(完全是我自己的错误),但结果还是成功获取了网页上的数据,进行了筛选,同意了。当然,输出的数据很多,我只剪了一小部分。你看到的最后一句 >>> for 循环块是迭代打印迭代器的内容,这里就不展示了。

最后的结果就是打印出大家的数据。

我的感觉是:Python可以做很多事情,搜索引擎在很大程度上利用了爬虫。 查看全部

c爬虫抓取网页数据(博客地址:Python入门(一)(图):爬虫)

题外话

我第一次听说 Python 是在我大二的时候。当时我没有学好C语言,所以不想学其他的编程语言。现在,我想在我的毕业项目中使用爬虫技术。上网查了一下,Python语言的爬虫技术得到了一致好评。

于是从昨天开始,在网上搜索了各种Python爬虫小程序的源码,可是一天过去了,不仅没有写出简单的爬虫程序,反而对Python应该编写的各种包和语法越来越糊涂了介绍。去菜鸟教程,Python语言比较复杂(虽然它的语法很简单,但是对于初学者来说,很多东西封装在一个包里是很陌生的),自己补了Python语法,然后开始搜索各种教程在网上,总之,我把别人写的爬虫入门级的程序都打出来了,但都没有奏效,还出现各种错误。

然而,我今天找到了一个博客。博主仔细讲了最简单的爬虫步骤,用到了哪些包,源代码也是逐句分析的,于是我的第一个爬虫程序就成功了。分享一下这位博主的博客,写下我的感受。

博客地址:Python入门(一):爬虫基本结构&简单例子。

我的实践

下图是我按照博主的代码得到的结果。虽然过程中出现了一点语法错误(完全是我自己的错误),但结果还是成功获取了网页上的数据,进行了筛选,同意了。当然,输出的数据很多,我只剪了一小部分。你看到的最后一句 >>> for 循环块是迭代打印迭代器的内容,这里就不展示了。

最后的结果就是打印出大家的数据。

我的感觉是:Python可以做很多事情,搜索引擎在很大程度上利用了爬虫。

c爬虫抓取网页数据(个人网站url的基本操作技巧分析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-11-19 14:03

c爬虫抓取网页数据,发一份个人网站url,再把数据传到服务器。

一、url的分析当然最直接的方法就是看你登录网站后,你的cookie是写到哪个文件的。

登录前登录后

1、看cookie设置url被写到本地存储文件,一般为mybatissession中。点击登录后,会访问本地存储文件(指定mybatis的存储路径),得到一个html文件。例如我们输入url'-gwuywjqyi9bfeeb3f0cu6u6jve8zifzxtdy2b9aoizg7rjym6eecvouew49z8z-gwuywjqyi9bfeeb3f0cu6u6jve8zifzxtdy2b9aoizg7rjym6eecvouew49z8z',可看到html文件包含10个id为'userinfo'的sql语句,一共有5w条数据。需要去查看这个sql语句有几行,按文件字节流的大小计算需要存储的字节。

2、web。xml中的布局设置web。xml代码如下:web。xmltitle。

3、判断url是否存在数据库如果上面2个方法无法确认url是否存在数据库,那么可以用“url如果存在数据库,则返回新的网页地址”的代码。url如果存在数据库,url存在的表中数据有重复,可以通过“根据mybatis.sql语句结果”的方式判断是否需要回传到数据库。注意,logwarning功能,不接受url中的带参数函数。

example如下:stringsql="mybatis.params.userinfo={employee.name}",返回新的网页地址。

4、根据mybatis.sql语句得到的网页地址中,字符串有java字符集,中文等区别,这个时候可以返回,同时将sql转换成javaconnectionfactory对象。判断sql,如果对应的java地址是同一个ip地址,则返回中文值。反之,返回数据库返回类型为byte数组,返回int等。

example如下:stringsql="if(java.inet.ip()>=17

3){system.out.println("localhost");}";接着抓取数据库,将获取到的ip地址和ip转换成byte数组,直接传给数据库就可以。

二、数据库设置

1、登录后访问url,并且登录的同时进行上面2中操作。在url获取到的数据库的表中有一个用户,此时分别进行查询这个用户表中的各项数据。 查看全部

c爬虫抓取网页数据(个人网站url的基本操作技巧分析)

c爬虫抓取网页数据,发一份个人网站url,再把数据传到服务器。

一、url的分析当然最直接的方法就是看你登录网站后,你的cookie是写到哪个文件的。

登录前登录后

1、看cookie设置url被写到本地存储文件,一般为mybatissession中。点击登录后,会访问本地存储文件(指定mybatis的存储路径),得到一个html文件。例如我们输入url'-gwuywjqyi9bfeeb3f0cu6u6jve8zifzxtdy2b9aoizg7rjym6eecvouew49z8z-gwuywjqyi9bfeeb3f0cu6u6jve8zifzxtdy2b9aoizg7rjym6eecvouew49z8z',可看到html文件包含10个id为'userinfo'的sql语句,一共有5w条数据。需要去查看这个sql语句有几行,按文件字节流的大小计算需要存储的字节。

2、web。xml中的布局设置web。xml代码如下:web。xmltitle。

3、判断url是否存在数据库如果上面2个方法无法确认url是否存在数据库,那么可以用“url如果存在数据库,则返回新的网页地址”的代码。url如果存在数据库,url存在的表中数据有重复,可以通过“根据mybatis.sql语句结果”的方式判断是否需要回传到数据库。注意,logwarning功能,不接受url中的带参数函数。

example如下:stringsql="mybatis.params.userinfo={employee.name}",返回新的网页地址。

4、根据mybatis.sql语句得到的网页地址中,字符串有java字符集,中文等区别,这个时候可以返回,同时将sql转换成javaconnectionfactory对象。判断sql,如果对应的java地址是同一个ip地址,则返回中文值。反之,返回数据库返回类型为byte数组,返回int等。

example如下:stringsql="if(java.inet.ip()>=17

3){system.out.println("localhost");}";接着抓取数据库,将获取到的ip地址和ip转换成byte数组,直接传给数据库就可以。

二、数据库设置

1、登录后访问url,并且登录的同时进行上面2中操作。在url获取到的数据库的表中有一个用户,此时分别进行查询这个用户表中的各项数据。

c爬虫抓取网页数据(java模板数据的爬取、关系的分析基于springboot。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 41 次浏览 • 2021-11-19 03:02

c爬虫抓取网页数据,是非常常见的工作。其中,页面的内容主要来自于html文档,文档内容也可分为多种形式。但总体来说,页面数据主要分为静态页面(比如各种pdf格式或word文档)和动态页面(比如flash页面)。动态页面由于时时刻刻都在发生变化,所以难以追踪数据的变化趋势,也导致数据无法进行可视化;静态页面不同,有一些html脚本语言(比如xml、xml2、xmlxpose等)在写完页面内容后就能产生原始的数据。

如果以特定语言模板抓取静态页面,则可以实现可视化。最近一年遇到几次使用模板抓取页面数据的需求,不能指望直接以php语言编写爬虫,而且使用php开发环境太麻烦了,也没有java、c#那样强大的工具,学习php可谓非常痛苦。今天提出使用以java为基础编写一个动态页面抓取工具。本文主要介绍java模板,数据的爬取、关系的分析基于springboot。

(其他工具配置与作用可直接查看java模板代码,在文末已附webj-loader包,不用自己找了)java模板定义一个java模板可以根据模板类构造器对模板数据进行配置。如果不要模板数据,就只通过string.asleep()方法确保string在该设置时的稳定性即可,在模板类的完整实现中是不调用string.asleep方法的。

java模板一般不对页面内容进行原始的string处理,所以需要对原始的html标签进行处理。另外,string的原始类型也需要做分析,如果string、html、markdown、json都是同一种原始类型,那么上面的配置就没有必要,直接用正则匹配就行了。java模板在源码中,参数是两类:string、java_html_text;分别对应原始html、java_html_text、java_html_text。

需要注意的是,如果输入参数中有null值,这里就直接使用null值。为了编写方便,在模板中对这两个参数统一进行了处理。源码中以“\0”为分隔符,原始输入参数中的两个0很容易被省略掉,因此尽量不要使用,除非该参数会产生问题。我将java_html_text和java_html_text进行了合并,即java_html_text=java_html_text+1(参数中appendable是“appendable”,java_html_text就是原始html页面里面的内容)。

在编写java模板时,一定要将原始html页面的格式转换为普通html标签,否则无法识别。其他配置因为在抓取数据时,抓取动态内容是必须的,所以这里没有对不同数据源分别配置数据采集页面的interceptor。而为了避免采集相同页面,这里的url_url参数就被忽略了,因为url_url是asp(.)的mime。 查看全部

c爬虫抓取网页数据(java模板数据的爬取、关系的分析基于springboot。)

c爬虫抓取网页数据,是非常常见的工作。其中,页面的内容主要来自于html文档,文档内容也可分为多种形式。但总体来说,页面数据主要分为静态页面(比如各种pdf格式或word文档)和动态页面(比如flash页面)。动态页面由于时时刻刻都在发生变化,所以难以追踪数据的变化趋势,也导致数据无法进行可视化;静态页面不同,有一些html脚本语言(比如xml、xml2、xmlxpose等)在写完页面内容后就能产生原始的数据。

如果以特定语言模板抓取静态页面,则可以实现可视化。最近一年遇到几次使用模板抓取页面数据的需求,不能指望直接以php语言编写爬虫,而且使用php开发环境太麻烦了,也没有java、c#那样强大的工具,学习php可谓非常痛苦。今天提出使用以java为基础编写一个动态页面抓取工具。本文主要介绍java模板,数据的爬取、关系的分析基于springboot。

(其他工具配置与作用可直接查看java模板代码,在文末已附webj-loader包,不用自己找了)java模板定义一个java模板可以根据模板类构造器对模板数据进行配置。如果不要模板数据,就只通过string.asleep()方法确保string在该设置时的稳定性即可,在模板类的完整实现中是不调用string.asleep方法的。

java模板一般不对页面内容进行原始的string处理,所以需要对原始的html标签进行处理。另外,string的原始类型也需要做分析,如果string、html、markdown、json都是同一种原始类型,那么上面的配置就没有必要,直接用正则匹配就行了。java模板在源码中,参数是两类:string、java_html_text;分别对应原始html、java_html_text、java_html_text。

需要注意的是,如果输入参数中有null值,这里就直接使用null值。为了编写方便,在模板中对这两个参数统一进行了处理。源码中以“\0”为分隔符,原始输入参数中的两个0很容易被省略掉,因此尽量不要使用,除非该参数会产生问题。我将java_html_text和java_html_text进行了合并,即java_html_text=java_html_text+1(参数中appendable是“appendable”,java_html_text就是原始html页面里面的内容)。

在编写java模板时,一定要将原始html页面的格式转换为普通html标签,否则无法识别。其他配置因为在抓取数据时,抓取动态内容是必须的,所以这里没有对不同数据源分别配置数据采集页面的interceptor。而为了避免采集相同页面,这里的url_url参数就被忽略了,因为url_url是asp(.)的mime。

c爬虫抓取网页数据(c爬虫抓取网页数据降低程序代码复杂度的方法教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-11-18 20:10

c爬虫抓取网页数据可以运用各种技术和框架,但是相比于开发一款正常的爬虫要更麻烦,对于一些不熟悉爬虫的人来说还是挺麻烦的。下面介绍一种能够极大降低程序代码复杂度的方法,用本教程教大家:用wxpython框架从网上爬取图片,转成markdown或者xml文件输出。第一步:读取图片数据爬取数据主要是读取网上爬取到的图片数据,用的是chrome开发者工具的浏览器插件开放内置的htmlextractor。