c爬虫抓取网页数据

c爬虫抓取网页数据(网络爬虫的基本工作流程:1.的发展基本流程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2022-02-26 00:31

下面是一个很励志的文章先跟大家分享。

信息论的发展

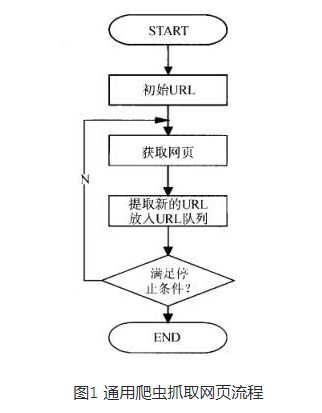

通过上一篇文章了解了爬虫的具体工作后,我们分析了网络爬虫的基本工作流程如下:

1.首先选择一个精心挑选的种子 URL 的子集;

2.将这些网址放入待抓取的网址队列中;

3. 从待爬取URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,存入下载的网页库中。此外,将这些 URL 放入 Crawl URL 队列。

4.分析已经爬取的URL队列中的URL,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

一、爬虫设计

从爬虫的角度来划分互联网,互联网的所有页面可以分为五个部分:

1.已下载未过期网页

2.下载和过期网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态变化的,互联网上的一些内容也发生了变化。您访问的页面已过期。

3.待下载网页:URL队列中待抓取的网页

4. 已知网页:没有被爬取过,也不在待爬取的URL队列中,但是通过分析已经爬取过的页面得到的URL或者待爬取的URL对应的页面可以视为已知网页。

5.还有一些网页是爬虫无法直接爬取下载的。称为不可知网页。

我们爬虫项目的主要事件流程大致如下:

1.获取命令行参数并执行相应操作

2.读取配置文件并解析得到各种设置

3.加载各种模块

4.种子入队,启动DNS解析线程(原队列不为空时解析)

5.创建epoll,启动任务,发起请求等,关注事件

6.在大循环中使用epoll_wait返回活动事件的同时,每个事件都会启动一个线程进行处理(该线程主要是解析页面、保存页面、url处理等),当线程结束。(或者程序初始化的时候创建线程池,没有任务的时候阻塞线程,通过pthread_cond_signal唤醒休眠队列中的线程,但是一个页面分析出来的有效URL会很多。这个时候我们甚至队列满时需要阻塞分析页面.url线程,使用线程池的好处是减少线程创建和销毁的系统开销)

在爬虫系统中,待爬取的 URL 队列是一个重要的部分。待爬取的URL队列中的URL的排列顺序也是一个重要的问题,因为它涉及到先爬到哪个页面,再爬到哪个页面。确定这些 URL 排列顺序的方法称为爬取策略。下面重点介绍几种常见的爬取策略(关于爬取策略优劣分析的建议,请阅读吴军老师《数学之美》第9章和第10章):

1.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,每次一个链接跟踪每个链接,处理完该行后移动到下一个起始页,并继续跟踪该链接。

2.广度优先遍历策略

广度优先遍历策略的基本思想是将新下载的网页中找到的链接直接插入待爬取URL队列的末尾。也就是说,网络爬虫会先爬取起始网页链接的所有网页,然后选择其中一个链接的网页,继续爬取该网页链接的所有网页。或者以上图为例:

3.反向链接计数策略

反向链接数是指从其他网页指向一个网页的链接数。反向链接的数量表示网页内容被他人推荐的程度。因此,在很多情况下,搜索引擎的爬取系统会使用这个指标来评估网页的重要性,从而确定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量并不能完全等同于他人的重要性。因此,搜索引擎倾向于考虑一些可靠的反向链接计数。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,与待爬取的URL队列中的URL一起,形成一组网页,计算每个页面的PageRank值. URL 按 PageRank 值排序,并按该顺序抓取页面。

如果每次爬取一个页面都重新计算一次PageRank值,折中的解决方案是:每爬完K个页面,重新计算一次PageRank值。但是这种情况还是有一个问题:对于下载页面中分析的链接,也就是我们前面提到的那部分未知网页,暂时没有PageRank值。为了解决这个问题,会给这些页面一个临时的PageRank值(比如1):总结这个页面所有传入链接传入的PageRank值(其实就是重复的大矩阵运算,未知站点的PageRank值会逐渐收敛到合适的值。说实话,收敛是我认为这个算法最漂亮的部分),从而形成了未知页面的PageRank值,

5.OPIC 政策政策

该算法实际上为页面分配了一个重要性分数。在算法开始之前,所有页面都会获得相同的初始现金。当某个页面P被下载时,P的现金分配给从P分析的所有链接,P的现金被清空。根据现金数量对待爬取URL队列中的所有页面进行排序。

6.大网站优先策略

所有待爬取的URL队列中的网页都按照它们所属的网站进行分类。网站需要下载的页面较多,请先下载。这种策略也称为大站点优先策略。

在下面 查看全部

c爬虫抓取网页数据(网络爬虫的基本工作流程:1.的发展基本流程)

下面是一个很励志的文章先跟大家分享。

信息论的发展

通过上一篇文章了解了爬虫的具体工作后,我们分析了网络爬虫的基本工作流程如下:

1.首先选择一个精心挑选的种子 URL 的子集;

2.将这些网址放入待抓取的网址队列中;

3. 从待爬取URL队列中取出待爬取的URL,解析DNS,获取主机IP,下载该URL对应的网页,存入下载的网页库中。此外,将这些 URL 放入 Crawl URL 队列。

4.分析已经爬取的URL队列中的URL,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

一、爬虫设计

从爬虫的角度来划分互联网,互联网的所有页面可以分为五个部分:

1.已下载未过期网页

2.下载和过期网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态变化的,互联网上的一些内容也发生了变化。您访问的页面已过期。

3.待下载网页:URL队列中待抓取的网页

4. 已知网页:没有被爬取过,也不在待爬取的URL队列中,但是通过分析已经爬取过的页面得到的URL或者待爬取的URL对应的页面可以视为已知网页。

5.还有一些网页是爬虫无法直接爬取下载的。称为不可知网页。

我们爬虫项目的主要事件流程大致如下:

1.获取命令行参数并执行相应操作

2.读取配置文件并解析得到各种设置

3.加载各种模块

4.种子入队,启动DNS解析线程(原队列不为空时解析)

5.创建epoll,启动任务,发起请求等,关注事件

6.在大循环中使用epoll_wait返回活动事件的同时,每个事件都会启动一个线程进行处理(该线程主要是解析页面、保存页面、url处理等),当线程结束。(或者程序初始化的时候创建线程池,没有任务的时候阻塞线程,通过pthread_cond_signal唤醒休眠队列中的线程,但是一个页面分析出来的有效URL会很多。这个时候我们甚至队列满时需要阻塞分析页面.url线程,使用线程池的好处是减少线程创建和销毁的系统开销)

在爬虫系统中,待爬取的 URL 队列是一个重要的部分。待爬取的URL队列中的URL的排列顺序也是一个重要的问题,因为它涉及到先爬到哪个页面,再爬到哪个页面。确定这些 URL 排列顺序的方法称为爬取策略。下面重点介绍几种常见的爬取策略(关于爬取策略优劣分析的建议,请阅读吴军老师《数学之美》第9章和第10章):

1.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,每次一个链接跟踪每个链接,处理完该行后移动到下一个起始页,并继续跟踪该链接。

2.广度优先遍历策略

广度优先遍历策略的基本思想是将新下载的网页中找到的链接直接插入待爬取URL队列的末尾。也就是说,网络爬虫会先爬取起始网页链接的所有网页,然后选择其中一个链接的网页,继续爬取该网页链接的所有网页。或者以上图为例:

3.反向链接计数策略

反向链接数是指从其他网页指向一个网页的链接数。反向链接的数量表示网页内容被他人推荐的程度。因此,在很多情况下,搜索引擎的爬取系统会使用这个指标来评估网页的重要性,从而确定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量并不能完全等同于他人的重要性。因此,搜索引擎倾向于考虑一些可靠的反向链接计数。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,与待爬取的URL队列中的URL一起,形成一组网页,计算每个页面的PageRank值. URL 按 PageRank 值排序,并按该顺序抓取页面。

如果每次爬取一个页面都重新计算一次PageRank值,折中的解决方案是:每爬完K个页面,重新计算一次PageRank值。但是这种情况还是有一个问题:对于下载页面中分析的链接,也就是我们前面提到的那部分未知网页,暂时没有PageRank值。为了解决这个问题,会给这些页面一个临时的PageRank值(比如1):总结这个页面所有传入链接传入的PageRank值(其实就是重复的大矩阵运算,未知站点的PageRank值会逐渐收敛到合适的值。说实话,收敛是我认为这个算法最漂亮的部分),从而形成了未知页面的PageRank值,

5.OPIC 政策政策

该算法实际上为页面分配了一个重要性分数。在算法开始之前,所有页面都会获得相同的初始现金。当某个页面P被下载时,P的现金分配给从P分析的所有链接,P的现金被清空。根据现金数量对待爬取URL队列中的所有页面进行排序。

6.大网站优先策略

所有待爬取的URL队列中的网页都按照它们所属的网站进行分类。网站需要下载的页面较多,请先下载。这种策略也称为大站点优先策略。

在下面

c爬虫抓取网页数据(用Python写网络爬虫(2.2三种网页抓取方法)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-02-26 00:29

阿里云>云栖社区>主题地图>C>c爬取网页列表数据库

推荐活动:

更多优惠>

当前话题:c爬取网页列表数据库添加到采集夹

相关话题:

c 爬取网页列表数据库相关博客查看更多博客

云数据库产品概述

作者:阿里云官网

ApsaraDB是稳定、可靠、可弹性扩展的在线数据库服务产品的总称。可以轻松运维全球90%以上的主流开源和商业数据库(MySQL、SQL Server、Redis等),同时为POLARDB提供6倍以上开源数据库的性能和开源的价格源数据库和自研的具有数百TB数据实时计算能力的HybridDB数据库等,并拥有容灾、备份、恢复、监控、迁移等一整套解决方案。

现在查看

Python爬取欧洲足球联赛数据进行大数据分析

作者:青山无名12610 浏览评论:14年前

背景 Web Scraping 在大数据时代,一切都得用数据说话。大数据处理的过程一般需要经过以下步骤:数据清洗、提取、加载数据的变形和分析、探索和预测数据的呈现方式。首先要做的是获取数据并提取有效数据,用于下一步分析。

阅读全文

使用 Scrapy 抓取数据

作者:御客6542 浏览评论:05年前

Scrapy 是一个用 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站并从页面中提取结构化数据。Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。官方主页:中文文档:Scrap

阅读全文

《用 Python 编写网络爬虫》——2.2 三种网络爬虫方法

作者:异步社区 3748人查看评论:04年前

本节书摘自异步社区《Writing Web Crawler in Python》一书第2章第2.2节,作者【澳大利亚】Richard Lawson,李斌翻译,更多内容章节可访问云栖社区“异步社区”公众号查看。2.2 三种网页抓取方式 既然我们已经了解了网页的结构,以下

阅读全文

初学者指南 | 使用 Python 进行网页抓取

作者:小旋风柴津2425查看评论:04年前

简介 从网页中提取信息的需求和重要性正在增长。每隔几周,我自己就想从网上获取一些信息。例如,上周我们考虑建立一个关于各种数据科学在线课程的受欢迎程度和意见指数。我们不仅需要识别新课程,还需要获取课程评论,总结它们并建立一些指标。

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:thinkyoung1544 人浏览评论:06年前

以前,我使用Java Jsoup 来捕获网页数据。前几天听说用PHP比较方便。今天简单研究了一下,主要是使用QueryList。QueryList 是一个基于 phpQ 的

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:Jack Chen 1527 浏览评论:06年前

原文:PHP使用QueryList来抓取网页内容。之前用Java Jsoup爬取网页数据。前几天听说用PHP爬取比较方便。今天研究了一下,主要是使用QueryList。QueryList 是一个基于 phpQuery 的泛型 list采集 类,简单、灵活、强大

阅读全文

[Android我的博客APP]1.爬取博客首页文章列出内容-网页数据抓取

作者:嗯9925975 浏览评论:04年前

如果打算在博客园制作自己的博客APP,首先要能够访问首页获取数据,获取首页的文章列表。第一步是抓取博客首页的内容 文章 功能已经实现,在小米2S上面的效果图如下: 思路是:通过写好的工具类访问网页,获取页面的源代码,通过正则表达式获取匹配的数据进行处理并显示到ListView

阅读全文

使用正则表达式爬取博客园列表数据

作者:建筑师郭郭860人浏览评论:09年前

鉴于我需要使用MVC 3中模仿博客园企业系统的测试数据来完成,自己输入太累了,所以我抓取了一些博客园的列表数据,请不要冒犯杜杜。采集博园数据时使用正则表达式,不熟悉正则表达式的朋友可以参考相关资料。其实很容易掌握,那就是

阅读全文 查看全部

c爬虫抓取网页数据(用Python写网络爬虫(2.2三种网页抓取方法)(组图))

阿里云>云栖社区>主题地图>C>c爬取网页列表数据库

推荐活动:

更多优惠>

当前话题:c爬取网页列表数据库添加到采集夹

相关话题:

c 爬取网页列表数据库相关博客查看更多博客

云数据库产品概述

作者:阿里云官网

ApsaraDB是稳定、可靠、可弹性扩展的在线数据库服务产品的总称。可以轻松运维全球90%以上的主流开源和商业数据库(MySQL、SQL Server、Redis等),同时为POLARDB提供6倍以上开源数据库的性能和开源的价格源数据库和自研的具有数百TB数据实时计算能力的HybridDB数据库等,并拥有容灾、备份、恢复、监控、迁移等一整套解决方案。

现在查看

Python爬取欧洲足球联赛数据进行大数据分析

作者:青山无名12610 浏览评论:14年前

背景 Web Scraping 在大数据时代,一切都得用数据说话。大数据处理的过程一般需要经过以下步骤:数据清洗、提取、加载数据的变形和分析、探索和预测数据的呈现方式。首先要做的是获取数据并提取有效数据,用于下一步分析。

阅读全文

使用 Scrapy 抓取数据

作者:御客6542 浏览评论:05年前

Scrapy 是一个用 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站并从页面中提取结构化数据。Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。官方主页:中文文档:Scrap

阅读全文

《用 Python 编写网络爬虫》——2.2 三种网络爬虫方法

作者:异步社区 3748人查看评论:04年前

本节书摘自异步社区《Writing Web Crawler in Python》一书第2章第2.2节,作者【澳大利亚】Richard Lawson,李斌翻译,更多内容章节可访问云栖社区“异步社区”公众号查看。2.2 三种网页抓取方式 既然我们已经了解了网页的结构,以下

阅读全文

初学者指南 | 使用 Python 进行网页抓取

作者:小旋风柴津2425查看评论:04年前

简介 从网页中提取信息的需求和重要性正在增长。每隔几周,我自己就想从网上获取一些信息。例如,上周我们考虑建立一个关于各种数据科学在线课程的受欢迎程度和意见指数。我们不仅需要识别新课程,还需要获取课程评论,总结它们并建立一些指标。

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:thinkyoung1544 人浏览评论:06年前

以前,我使用Java Jsoup 来捕获网页数据。前几天听说用PHP比较方便。今天简单研究了一下,主要是使用QueryList。QueryList 是一个基于 phpQ 的

阅读全文

PHP 使用 QueryList 抓取网页内容

作者:Jack Chen 1527 浏览评论:06年前

原文:PHP使用QueryList来抓取网页内容。之前用Java Jsoup爬取网页数据。前几天听说用PHP爬取比较方便。今天研究了一下,主要是使用QueryList。QueryList 是一个基于 phpQuery 的泛型 list采集 类,简单、灵活、强大

阅读全文

[Android我的博客APP]1.爬取博客首页文章列出内容-网页数据抓取

作者:嗯9925975 浏览评论:04年前

如果打算在博客园制作自己的博客APP,首先要能够访问首页获取数据,获取首页的文章列表。第一步是抓取博客首页的内容 文章 功能已经实现,在小米2S上面的效果图如下: 思路是:通过写好的工具类访问网页,获取页面的源代码,通过正则表达式获取匹配的数据进行处理并显示到ListView

阅读全文

使用正则表达式爬取博客园列表数据

作者:建筑师郭郭860人浏览评论:09年前

鉴于我需要使用MVC 3中模仿博客园企业系统的测试数据来完成,自己输入太累了,所以我抓取了一些博客园的列表数据,请不要冒犯杜杜。采集博园数据时使用正则表达式,不熟悉正则表达式的朋友可以参考相关资料。其实很容易掌握,那就是

阅读全文

c爬虫抓取网页数据(日常网站维护中,哪些操作可以让爬虫更加频繁和高效?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-02-25 05:02

对于很多中小站长来说,尤其是Seoer。吸引爬虫的频繁爬取是获得大量 收录 和良好排名的关键因素。那么,在我们日常的网站维护中,有哪些操作可以让爬虫爬得更频繁更高效呢?

有很多朋友想说,这不简单,“增加网站的权重、增加发帖频率、提高文章的质量、加强传入链接、加强页面深度等。” 可以有效提高网站@网站爬虫的爬取频率。显然,这些对 Seoor 来说太熟悉了。但是所有的想法都只是想法,不是每个人都有很高的权重网站,每个人都有强大的编辑团队,策划团队,开发团队,推广团队......如果你拥有所有这些好吧,那么,你不会被“君行动”的称号所吸引。

问题是,你有没有过这样的疑问,我们的竞争对手和我们的网站在大小、重量和文章质量上是一样的,甚至网站的整体结构也非常相似。为什么在几乎一样的情况下,对方的排名总是比我们高?雪儿无论怎么努力、绞尽脑汁,加班加点都打不过对手。然后脑子里各种抱怨,抱怨上天的不公平,世间的不公平,为什么我没有生为王思聪……(其实没有什么是公平的,但是想了想是不如通过自己的努力让自己成为下一个马云?哈哈哈好像有点跑题了……咳~)

坦白告诉你,解决以上问题的方法有很多,就看你有没有发现和研究过!众所周知,无论是国际还是国内,搜索引擎技术始终是互联网的第一生命线,也是互联网的核心技术。它就像一张大网,肩负着网民从世界各地获取信息的重任。很难想象,如果有一天,没有搜索引擎,人们的生活习惯会发生怎样的变化?或许比失恋更可怕,那种你无法想象的孤独!言归正传,目前,中国四大热门搜索引擎百度、360、搜狗、移动神马,都在不断变化和创新。对于中小型站长,他们所能做的,就是屏住呼吸,“服从”这些老板。他们的胃口,千万不要在不经意间,被打成一个注定要失败的地方。

兵:《孙子·阴谋》云:“知己知彼,百战不殆。” 在做seo的过程中,一方面要学会适应时代的变化,另一方面要“懂领导”。就像在职场中一样,获得老板的认可和肯定最直接的方式就是把握老板的期望和想法。今天,首席运营官将深入敌方阵营,从搜索引擎的角度,为大家讲解中小站长如何提高网站被爬虫爬取的频率。

全网大小网页数以千万计,搜索引擎每次爬取后都需要更新网页。请注意,Internet 是动态的,随时都会出现新页面或更改页面。早期被爬虫爬取并保存在搜索引擎网络库中的页面也可能有不同的信息,或者由于各种因素而被删除。一旦这些页面被用户检索,导致无法访问,或者访问与原创页面信息不一致,糟糕的用户体验可想而知。因此,为避免上述情况,搜索引擎需要对已下载或未下载的页面进行实时重复爬取,以保证搜索结果与搜索引擎数据库一致。

搜索引擎网页更新策略一:历史参考策略

顾名思义,历史更新策略就是参考网站历史发布信息的频率进行爬取。它基于以下假设。过去经常更新的网页,将来也会经常更新。为了估计一个网页什么时候有新的内容,它可以参考它的历史更新情况来做出决定。所以站长和SEOer一方面需要更新很多内容,另一方面要定期更新内容。那么,如何定期更新内容呢?这很简单。比如网站更新文章的次数限制为每天5个,那么我们就计划好内容更新点,在某个时间点分发这5个内容,定期更新。确认更新点后,它需要成为下一次每日更新的标准并坚持下去。久而久之,你会发现提高爬虫的爬取频率就是这么简单!操作个人测试,定期更新长时间也可以增加收录的音量,甚至达到秒收的效果。图像更新也是如此。

搜索引擎网页更新策略二:用户体验策略

用户体验站长知道有效的用户体验可以提高页面排名。很多时候,当用户搜索某个关键词时,他们浏览的页面有90%被限制在前三页。他们走得越远,他们看的频率就越低。基于这种情况,搜索引擎会优先更新排名靠前的页面。需要了解的是,爬虫爬完页面后,会创建一个页库,比如某个页面P,页库中会有多个版本,版本数取决于页数更新,搜索引擎会获取页面在排名中的平均值,作为判断爬取页面时机的重要参考。影响力越大的页面,它将安排重新抓取的优先级越高。显然,优秀的用户体验可以有效带动爬虫的爬取频率。

搜索引擎网页更新策略三:爬取环境策略

什么是 Grab 环境政策?简单的解释就是爬虫访问的页面爬取是否顺畅。这部分涉及多个层面,如异常爬取、服务器连接异常、网络运营商异常、无法解析IP导致的DNS异常、IP封禁、死链接等。这里主要给大家讲解一下抓取的异常情况!比如去哪儿、12306等一些网页可能会导致爬虫爬取异常。(图1:参考去哪儿网) 该页面需要用户进行实际验证操作,才能登录数据库显示更大的内容。这部分内容对于搜索引擎来说是很难爬取的,业内称为暗网爬取,目前所有的搜索引擎都无法实现这个爬取问题。谷歌' 目前的重点研究方向也在这里,而百度的“阿拉丁计划”就是为了解决这个问题。因此,为了打造一个优秀的爬虫爬取环境,在我们的网站中,尽量避免使用上述类似的模块功能。如果实在无法避免,就需要简化代码或者做一定的爬虫。指导。以免造成爬虫难以爬取,误认为页面不友好,甚至不爬。更不用说频繁的爬行了。有必要简化代码或制作一定的爬虫。指导。以免造成爬虫难以爬取,误认为页面不友好,甚至不爬。更不用说频繁的爬行了。有必要简化代码或制作一定的爬虫。指导。以免造成爬虫难以爬取,误认为页面不友好,甚至不爬。更不用说频繁的爬行了。

(图1)

搜索引擎网页更新策略四:整群抽样策略

Seoer知道关键词是一个网页的标签,就像汽车一样,标签有很多,比如品牌、型号、颜色、性能等等。当然,大部分机型都会量产,存在重复出现的现象。搜索引擎的聚类抽样策略也是基于这个思想。聚类抽样策略认为所有的网页都有一些属性,可以根据这些属性确定它们的更新周期。具有相似属性的网页的更新周期也相似。因此,爬虫在爬取页面之前,会对一些页面进行分类,分类依据大致是指两个特征:

1、静态特征:页面内容、图片数量、页面大小、链接深度、pagerank值等。

2、动态特性:内容量的变化、进出链接的变化等。

根据上述变化,搜索引擎会对它们进行有效的分类。示例:爬虫爬取的一个类别包括a、b、c、d、e、f、g 7个页面,从该类别中提取出一部分最具代表性的网页(一般是离类别中心最近的网页)被提取),计算这些网页的更新周期,可以粗略确定这个更新周期适用于该类别中的所有页面。那么,根据搜索引擎的聚类抽样策略,我们该如何优化来提高爬虫的爬取频率呢?首先,要有明确的关键词定位,让爬虫第一眼就能判断出页面的类别。其次,内容更新频率可以参考优质网站的更新频率。长期优化可以让搜索引擎把你归类为一些高权重的页面。如果是这样,获得爬虫的青睐还远吗??

通过搜索引擎爬虫的四点网页更新策略,大家一定有一些启示。网站优化之路漫长。不管搜索引擎如何改变规则,最终目标仍然是打造一个以用户体验为核心的完美国家。只要我们可以从搜索引擎的角度出发,考虑用户行为和用户体验。小树苗长成参天大树,成为总裁嫁给白富美不是梦。至于你为什么是“不是天生的王思聪”这种白痴问题,别问我,我懒得回答!

免责声明:本文文章均为@首席运营君本人撰写原创(图片来源于网络),未经允许请勿转载。 查看全部

c爬虫抓取网页数据(日常网站维护中,哪些操作可以让爬虫更加频繁和高效?)

对于很多中小站长来说,尤其是Seoer。吸引爬虫的频繁爬取是获得大量 收录 和良好排名的关键因素。那么,在我们日常的网站维护中,有哪些操作可以让爬虫爬得更频繁更高效呢?

有很多朋友想说,这不简单,“增加网站的权重、增加发帖频率、提高文章的质量、加强传入链接、加强页面深度等。” 可以有效提高网站@网站爬虫的爬取频率。显然,这些对 Seoor 来说太熟悉了。但是所有的想法都只是想法,不是每个人都有很高的权重网站,每个人都有强大的编辑团队,策划团队,开发团队,推广团队......如果你拥有所有这些好吧,那么,你不会被“君行动”的称号所吸引。

问题是,你有没有过这样的疑问,我们的竞争对手和我们的网站在大小、重量和文章质量上是一样的,甚至网站的整体结构也非常相似。为什么在几乎一样的情况下,对方的排名总是比我们高?雪儿无论怎么努力、绞尽脑汁,加班加点都打不过对手。然后脑子里各种抱怨,抱怨上天的不公平,世间的不公平,为什么我没有生为王思聪……(其实没有什么是公平的,但是想了想是不如通过自己的努力让自己成为下一个马云?哈哈哈好像有点跑题了……咳~)

坦白告诉你,解决以上问题的方法有很多,就看你有没有发现和研究过!众所周知,无论是国际还是国内,搜索引擎技术始终是互联网的第一生命线,也是互联网的核心技术。它就像一张大网,肩负着网民从世界各地获取信息的重任。很难想象,如果有一天,没有搜索引擎,人们的生活习惯会发生怎样的变化?或许比失恋更可怕,那种你无法想象的孤独!言归正传,目前,中国四大热门搜索引擎百度、360、搜狗、移动神马,都在不断变化和创新。对于中小型站长,他们所能做的,就是屏住呼吸,“服从”这些老板。他们的胃口,千万不要在不经意间,被打成一个注定要失败的地方。

兵:《孙子·阴谋》云:“知己知彼,百战不殆。” 在做seo的过程中,一方面要学会适应时代的变化,另一方面要“懂领导”。就像在职场中一样,获得老板的认可和肯定最直接的方式就是把握老板的期望和想法。今天,首席运营官将深入敌方阵营,从搜索引擎的角度,为大家讲解中小站长如何提高网站被爬虫爬取的频率。

全网大小网页数以千万计,搜索引擎每次爬取后都需要更新网页。请注意,Internet 是动态的,随时都会出现新页面或更改页面。早期被爬虫爬取并保存在搜索引擎网络库中的页面也可能有不同的信息,或者由于各种因素而被删除。一旦这些页面被用户检索,导致无法访问,或者访问与原创页面信息不一致,糟糕的用户体验可想而知。因此,为避免上述情况,搜索引擎需要对已下载或未下载的页面进行实时重复爬取,以保证搜索结果与搜索引擎数据库一致。

搜索引擎网页更新策略一:历史参考策略

顾名思义,历史更新策略就是参考网站历史发布信息的频率进行爬取。它基于以下假设。过去经常更新的网页,将来也会经常更新。为了估计一个网页什么时候有新的内容,它可以参考它的历史更新情况来做出决定。所以站长和SEOer一方面需要更新很多内容,另一方面要定期更新内容。那么,如何定期更新内容呢?这很简单。比如网站更新文章的次数限制为每天5个,那么我们就计划好内容更新点,在某个时间点分发这5个内容,定期更新。确认更新点后,它需要成为下一次每日更新的标准并坚持下去。久而久之,你会发现提高爬虫的爬取频率就是这么简单!操作个人测试,定期更新长时间也可以增加收录的音量,甚至达到秒收的效果。图像更新也是如此。

搜索引擎网页更新策略二:用户体验策略

用户体验站长知道有效的用户体验可以提高页面排名。很多时候,当用户搜索某个关键词时,他们浏览的页面有90%被限制在前三页。他们走得越远,他们看的频率就越低。基于这种情况,搜索引擎会优先更新排名靠前的页面。需要了解的是,爬虫爬完页面后,会创建一个页库,比如某个页面P,页库中会有多个版本,版本数取决于页数更新,搜索引擎会获取页面在排名中的平均值,作为判断爬取页面时机的重要参考。影响力越大的页面,它将安排重新抓取的优先级越高。显然,优秀的用户体验可以有效带动爬虫的爬取频率。

搜索引擎网页更新策略三:爬取环境策略

什么是 Grab 环境政策?简单的解释就是爬虫访问的页面爬取是否顺畅。这部分涉及多个层面,如异常爬取、服务器连接异常、网络运营商异常、无法解析IP导致的DNS异常、IP封禁、死链接等。这里主要给大家讲解一下抓取的异常情况!比如去哪儿、12306等一些网页可能会导致爬虫爬取异常。(图1:参考去哪儿网) 该页面需要用户进行实际验证操作,才能登录数据库显示更大的内容。这部分内容对于搜索引擎来说是很难爬取的,业内称为暗网爬取,目前所有的搜索引擎都无法实现这个爬取问题。谷歌' 目前的重点研究方向也在这里,而百度的“阿拉丁计划”就是为了解决这个问题。因此,为了打造一个优秀的爬虫爬取环境,在我们的网站中,尽量避免使用上述类似的模块功能。如果实在无法避免,就需要简化代码或者做一定的爬虫。指导。以免造成爬虫难以爬取,误认为页面不友好,甚至不爬。更不用说频繁的爬行了。有必要简化代码或制作一定的爬虫。指导。以免造成爬虫难以爬取,误认为页面不友好,甚至不爬。更不用说频繁的爬行了。有必要简化代码或制作一定的爬虫。指导。以免造成爬虫难以爬取,误认为页面不友好,甚至不爬。更不用说频繁的爬行了。

(图1)

搜索引擎网页更新策略四:整群抽样策略

Seoer知道关键词是一个网页的标签,就像汽车一样,标签有很多,比如品牌、型号、颜色、性能等等。当然,大部分机型都会量产,存在重复出现的现象。搜索引擎的聚类抽样策略也是基于这个思想。聚类抽样策略认为所有的网页都有一些属性,可以根据这些属性确定它们的更新周期。具有相似属性的网页的更新周期也相似。因此,爬虫在爬取页面之前,会对一些页面进行分类,分类依据大致是指两个特征:

1、静态特征:页面内容、图片数量、页面大小、链接深度、pagerank值等。

2、动态特性:内容量的变化、进出链接的变化等。

根据上述变化,搜索引擎会对它们进行有效的分类。示例:爬虫爬取的一个类别包括a、b、c、d、e、f、g 7个页面,从该类别中提取出一部分最具代表性的网页(一般是离类别中心最近的网页)被提取),计算这些网页的更新周期,可以粗略确定这个更新周期适用于该类别中的所有页面。那么,根据搜索引擎的聚类抽样策略,我们该如何优化来提高爬虫的爬取频率呢?首先,要有明确的关键词定位,让爬虫第一眼就能判断出页面的类别。其次,内容更新频率可以参考优质网站的更新频率。长期优化可以让搜索引擎把你归类为一些高权重的页面。如果是这样,获得爬虫的青睐还远吗??

通过搜索引擎爬虫的四点网页更新策略,大家一定有一些启示。网站优化之路漫长。不管搜索引擎如何改变规则,最终目标仍然是打造一个以用户体验为核心的完美国家。只要我们可以从搜索引擎的角度出发,考虑用户行为和用户体验。小树苗长成参天大树,成为总裁嫁给白富美不是梦。至于你为什么是“不是天生的王思聪”这种白痴问题,别问我,我懒得回答!

免责声明:本文文章均为@首席运营君本人撰写原创(图片来源于网络),未经允许请勿转载。

c爬虫抓取网页数据(写入值到word二、spider爬取标题进行写入三、爬去代码并将代码进行装换遇到问题 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-02-24 14:09

)

一、将值写入word 二、蜘蛛爬取标题供写三、爬取代码并替换代码遇到的问题:

在代码块中,每个字符都用一个 span 包裹

这种方法可以直接获取代码的值,可以用它来获取代码思路一、直接模仿代码进行在线替换,编写操作思路二、使用文件操作技术获取替换的代码,然后使用脚本将其复制并粘贴到word文档中。 Ideas三、通过拼接直接得到的span标签的值,将拼接后的值传入word(select)中,最后使用etree执行代码块。解析项目遇到的工具:

(etree)

(查询)

代码:

import requests

from bs4 import BeautifulSoup

from pyquery import PyQuery as pq

from lxml import etree

from docx import Document

from docx.shared import Inches

url="https://www.runoob.com/cprogra ... ot%3B

def geu_page(url):

try:

res = requests.get(url,timeout=4)

res.encoding = 'utf-8'

if res.status_code == 200:

html = res.text

return html.encode("utf-8")

except Exception as e:

for i in range(3):

print(url,e)

res = requests.get(url,timeout=4)

res.encoding = 'utf-8'

if res.status_code == 200:

html = res.text

return html.encode('utf-8')

def getdata(url1):

html1 = geu_page(url1)

doc = pq(html1) # 解析html文件

datas = etree.HTML(html1)

data = datas.xpath('//div[@class="hl-main"]/span/text()')

code = ''.join(data)

title = doc('#content > p:nth-child(3)').text() # 其中doc(使用的是selector选择器)

content = doc('#content > p:nth-child(4)').text()

# 对url进行切割获取下标

begin = url1.find("example")

end = url1.find(".html")

index = url1[begin + 7:end]

print("开始写入第"+index+"个实例")

write_to_word(code,title,content,head=index)

def write_to_word(code,title,content,head):

# 标题

document.add_heading("C语言实例"+str(head), level=0)

# 文本: 题目

document.add_paragraph(title)

# 文本: 程序分析

document.add_paragraph(content)

# 代码: 代码

document.add_paragraph(code)

# 结果: result

document = Document()

for i in range(1,101):

url1=url+str(i)+".html"

getdata(url1)

document.save('C 语言经典100例.docx')

ent()

for i in range(1,101):

url1=url+str(i)+".html"

getdata(url1)

document.save('C 语言经典100例.docx') 查看全部

c爬虫抓取网页数据(写入值到word二、spider爬取标题进行写入三、爬去代码并将代码进行装换遇到问题

)

一、将值写入word 二、蜘蛛爬取标题供写三、爬取代码并替换代码遇到的问题:

在代码块中,每个字符都用一个 span 包裹

这种方法可以直接获取代码的值,可以用它来获取代码思路一、直接模仿代码进行在线替换,编写操作思路二、使用文件操作技术获取替换的代码,然后使用脚本将其复制并粘贴到word文档中。 Ideas三、通过拼接直接得到的span标签的值,将拼接后的值传入word(select)中,最后使用etree执行代码块。解析项目遇到的工具:

(etree)

(查询)

代码:

import requests

from bs4 import BeautifulSoup

from pyquery import PyQuery as pq

from lxml import etree

from docx import Document

from docx.shared import Inches

url="https://www.runoob.com/cprogra ... ot%3B

def geu_page(url):

try:

res = requests.get(url,timeout=4)

res.encoding = 'utf-8'

if res.status_code == 200:

html = res.text

return html.encode("utf-8")

except Exception as e:

for i in range(3):

print(url,e)

res = requests.get(url,timeout=4)

res.encoding = 'utf-8'

if res.status_code == 200:

html = res.text

return html.encode('utf-8')

def getdata(url1):

html1 = geu_page(url1)

doc = pq(html1) # 解析html文件

datas = etree.HTML(html1)

data = datas.xpath('//div[@class="hl-main"]/span/text()')

code = ''.join(data)

title = doc('#content > p:nth-child(3)').text() # 其中doc(使用的是selector选择器)

content = doc('#content > p:nth-child(4)').text()

# 对url进行切割获取下标

begin = url1.find("example")

end = url1.find(".html")

index = url1[begin + 7:end]

print("开始写入第"+index+"个实例")

write_to_word(code,title,content,head=index)

def write_to_word(code,title,content,head):

# 标题

document.add_heading("C语言实例"+str(head), level=0)

# 文本: 题目

document.add_paragraph(title)

# 文本: 程序分析

document.add_paragraph(content)

# 代码: 代码

document.add_paragraph(code)

# 结果: result

document = Document()

for i in range(1,101):

url1=url+str(i)+".html"

getdata(url1)

document.save('C 语言经典100例.docx')

ent()

for i in range(1,101):

url1=url+str(i)+".html"

getdata(url1)

document.save('C 语言经典100例.docx')

c爬虫抓取网页数据(- )

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2022-02-21 23:26

)

我们的使命:抓取网页内容

1.用户指定的url

2.获取所有文章文本

urllib的request模块可以很方便的抓取URL内容,即向指定页面发送GET请求,然后返回HTTP响应

Python 通过 re 模块提供对正则表达式的支持

from urllib import request

import re

用户输入指定的url

#地址 绑定(编程期间)

#user_url = "https://news.sina.com.cn/o/201 ... ot%3B

#地址 由用户指定(使用期间)

print("请输入您想查看的url")

user_url = input()

请输入您想查看的url

https://www.cnblogs.com/ms-uap/p/9928254.html

获取网页html信息并转码

添加头信息,反爬虫策略

我们需要url的标题和文章进行分析。

提取我匹配代码的title标签的正则表达式

title = re.findall('(.*?[\u4e00-\u9fa5]*?.*?)', data_web)

for line in title:

print(line)

系列之1-神经网络的基本工作原理 - UniversalAIPlatform - 博客园

提取p标签的正则表达式我的匹配码

article = re.findall('(.*?[\u4e00-\u9fa5]*?.*?)', data_web)

for line in article:

print(line)</p> 查看全部

c爬虫抓取网页数据(-

)

我们的使命:抓取网页内容

1.用户指定的url

2.获取所有文章文本

urllib的request模块可以很方便的抓取URL内容,即向指定页面发送GET请求,然后返回HTTP响应

Python 通过 re 模块提供对正则表达式的支持

from urllib import request

import re

用户输入指定的url

#地址 绑定(编程期间)

#user_url = "https://news.sina.com.cn/o/201 ... ot%3B

#地址 由用户指定(使用期间)

print("请输入您想查看的url")

user_url = input()

请输入您想查看的url

https://www.cnblogs.com/ms-uap/p/9928254.html

获取网页html信息并转码

添加头信息,反爬虫策略

我们需要url的标题和文章进行分析。

提取我匹配代码的title标签的正则表达式

title = re.findall('(.*?[\u4e00-\u9fa5]*?.*?)', data_web)

for line in title:

print(line)

系列之1-神经网络的基本工作原理 - UniversalAIPlatform - 博客园

提取p标签的正则表达式我的匹配码

article = re.findall('(.*?[\u4e00-\u9fa5]*?.*?)', data_web)

for line in article:

print(line)</p>

c爬虫抓取网页数据(c爬虫抓取网页数据工具:lexpress+f12(会出现一个commonlayouturl的缩略图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2022-02-21 02:01

c爬虫抓取网页数据工具:lexpress。net6。3。4基本使用方法:ctrl+f12(会出现一个commonlayouturl的缩略图),如下:则显示centrallist,具体使用方法,见此;ctrl+g则显示很多很多列到底哪些才是centrallist中的数据,需要以列的方式进行搜索(默认的搜索一列就可以搜索到啦!),比如我爬取的只有:“城市a,b,c,d,e”,则我将搜索出来的都放到列中,这样可以这列中的所有东西都爬取到(否则不够多啊啊啊!);ctrl+h也是进行清空(否则检查数据的时候,会想现在有xxx行有些东西出现了但是我确定没有收录进来,然后数据会报错);ctrl+dctrl+j我将爬虫数据提取出来放到表中了,但是以列的方式存在list中;这个比较简单,没有关系;如果发现某个页面爬取不到,就用```循环到具体的页面中,则就存在list中的数据了(list中是被哪个页面捕获到的数据存在一个列表中);感觉自己在写爬虫的时候,总是写不到表中,让人很崩溃!欢迎我一起爬虫交流哈哈哈哈!!!。

lens主要功能是爬取网页的数据,不过我觉得ctrl+f5可以列出一个页面数据,其他的可以继续重复。等待很久,就是一种没有反馈的等待,如果爬取完了,他会发消息,告诉你爬取完成了,但是这次并不是从本页爬取,如果自己想要从一个网页爬取,可以点击列表项进行爬取,也可以采用其他的方式,上面说的列表项不适用于有一些敏感字眼的数据爬取,比如身份证号和手机号之类的,其他的都可以自己列出以列表项的方式, 查看全部

c爬虫抓取网页数据(c爬虫抓取网页数据工具:lexpress+f12(会出现一个commonlayouturl的缩略图))

c爬虫抓取网页数据工具:lexpress。net6。3。4基本使用方法:ctrl+f12(会出现一个commonlayouturl的缩略图),如下:则显示centrallist,具体使用方法,见此;ctrl+g则显示很多很多列到底哪些才是centrallist中的数据,需要以列的方式进行搜索(默认的搜索一列就可以搜索到啦!),比如我爬取的只有:“城市a,b,c,d,e”,则我将搜索出来的都放到列中,这样可以这列中的所有东西都爬取到(否则不够多啊啊啊!);ctrl+h也是进行清空(否则检查数据的时候,会想现在有xxx行有些东西出现了但是我确定没有收录进来,然后数据会报错);ctrl+dctrl+j我将爬虫数据提取出来放到表中了,但是以列的方式存在list中;这个比较简单,没有关系;如果发现某个页面爬取不到,就用```循环到具体的页面中,则就存在list中的数据了(list中是被哪个页面捕获到的数据存在一个列表中);感觉自己在写爬虫的时候,总是写不到表中,让人很崩溃!欢迎我一起爬虫交流哈哈哈哈!!!。

lens主要功能是爬取网页的数据,不过我觉得ctrl+f5可以列出一个页面数据,其他的可以继续重复。等待很久,就是一种没有反馈的等待,如果爬取完了,他会发消息,告诉你爬取完成了,但是这次并不是从本页爬取,如果自己想要从一个网页爬取,可以点击列表项进行爬取,也可以采用其他的方式,上面说的列表项不适用于有一些敏感字眼的数据爬取,比如身份证号和手机号之类的,其他的都可以自己列出以列表项的方式,

c爬虫抓取网页数据(抓取智联招聘的招聘信息助你换工作成功(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 316 次浏览 • 2022-02-20 16:02

)

每个上班族都要换几次工作,那么如何在网上找到自己喜欢的工作呢?如何提前准备理想工作的面试?今天,就让我们一起来抢夺智联招聘的招聘信息,助你转业成功!

操作平台:Windows

Python版本:Python3.6

IDE:崇高文本

其他工具:Chrome浏览器

1、网页分析1.1 分析请求地址

以北京海淀区一位python工程师为例进行网页分析。打开智联招聘首页,选择北京地区,在搜索框中输入“python工程师”,点击“搜索职位”:

接下来跳转到搜索结果页面,按“F12”打开开发者工具,然后在“热门区域”一栏中选择“海淀”,我们看一下地址栏:

从地址栏的后半部分,searchresult.ashx?jl=Beijing&kw=python Engineer&sm=0&isfilter=1&p=1&re=2005 可以看出,我们要自己构造地址。接下来,我们需要分析开发者工具,按照图中的步骤找到我们需要的数据:Request Headers 和 Query String Parameters:

构造请求地址:

paras = {

'jl': '北京', # 搜索城市

'kw': 'python工程师', # 搜索关键词

'isadv': 0, # 是否打开更详细搜索选项

'isfilter': 1, # 是否对结果过滤

'p': 1, # 页数

're': 2005 # region的缩写,地区,2005代表海淀

}

url = 'https://sou.zhaopin.com/jobs/s ... 39%3B + urlencode(paras)

请求头:

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'Host': 'sou.zhaopin.com',

'Referer': 'https://www.zhaopin.com/',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9'

}

1.2 分析有用的数据

接下来,我们需要分析有用的数据。我们从搜索结果中需要的数据有:职位、公司名称、公司详情页地址、月薪:

通过网页元素定位找到这些项目在HTML文件中的位置,如下图所示:

使用正则表达式提取这四项:

# 正则表达式进行解析

pattern = re.compile('<a style=.*? target="_blank">(.*?)</a>.*?' # 匹配职位信息

'(.*?).*?' # 匹配公司网址和公司名称

'(.*?)', re.S) # 匹配月薪

# 匹配所有符合条件的内容

items = re.findall(pattern, html)

注意:部分解析出来的作业名有标签,如下图所示:

然后解析后需要对数据进行处理,去掉标签,用如下代码实现:

for item in items:

job_name = item[0]

job_name = job_name.replace('', '')

job_name = job_name.replace('', '')

yield {

'job': job_name,

'website': item[1],

'company': item[2],

'salary': item[3]

}

2、写入文件

我们得到的数据的信息项对于每个位置都是一样的,可以写入数据库,但是本文选择的是csv文件。以下是百度百科的解释:

逗号分隔值(Comma-Separated Values,CSV,有时也称为字符分隔值,因为分隔字符也可以不是逗号),其文件以纯文本形式存储表格数据(数字和文本)。纯文本意味着该文件是一个字符序列,不含必须像二进制数字那样被解读的数据。

由于python内置了csv文件操作的库函数,非常方便:

import csv

def write_csv_headers(path, headers):

'''

写入表头

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

def write_csv_rows(path, headers, rows):

'''

写入行

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writerows(rows)

3、进度显示

为了找到理想的工作,我们必须筛选更多的职位,那么我们爬取的数据量必须非常大,几十、几百甚至上千页,那么我们必须掌握爬取的进度,以便更多地在舒适。啊,所以要添加进度条显示功能。

本文选择tqdm进行进度展示,我们来看看炫酷的结果(图片来源网络):

执行以下命令进行安装:pip install tqdm。

简单的例子:

from tqdm import tqdm

from time import sleep

for i in tqdm(range(1000)):

sleep(0.01)

4、完整代码

以上是对所有函数的分析,以下是完整代码:

#-*- coding: utf-8 -*-

import re

import csv

import requests

from tqdm import tqdm

from urllib.parse import urlencode

from requests.exceptions import RequestException

def get_one_page(city, keyword, region, page):

'''

获取网页html内容并返回

'''

paras = {

'jl': city, # 搜索城市

'kw': keyword, # 搜索关键词

'isadv': 0, # 是否打开更详细搜索选项

'isfilter': 1, # 是否对结果过滤

'p': page, # 页数

're': region # region的缩写,地区,2005代表海淀

}

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'Host': 'sou.zhaopin.com',

'Referer': 'https://www.zhaopin.com/',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9'

}

url = 'https://sou.zhaopin.com/jobs/s ... 39%3B + urlencode(paras)

try:

# 获取网页内容,返回html数据

response = requests.get(url, headers=headers)

# 通过状态码判断是否获取成功

if response.status_code == 200:

return response.text

return None

except RequestException as e:

return None

def parse_one_page(html):

'''

解析HTML代码,提取有用信息并返回

'''

# 正则表达式进行解析

pattern = re.compile('<a style=.*? target="_blank">(.*?)</a>.*?' # 匹配职位信息

'(.*?).*?' # 匹配公司网址和公司名称

'(.*?)', re.S) # 匹配月薪

# 匹配所有符合条件的内容

items = re.findall(pattern, html)

for item in items:

job_name = item[0]

job_name = job_name.replace('', '')

job_name = job_name.replace('', '')

yield {

'job': job_name,

'website': item[1],

'company': item[2],

'salary': item[3]

}

def write_csv_file(path, headers, rows):

'''

将表头和行写入csv文件

'''

# 加入encoding防止中文写入报错

# newline参数防止每写入一行都多一个空行

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

f_csv.writerows(rows)

def write_csv_headers(path, headers):

'''

写入表头

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

def write_csv_rows(path, headers, rows):

'''

写入行

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writerows(rows)

def main(city, keyword, region, pages):

'''

主函数

'''

filename = 'zl_' + city + '_' + keyword + '.csv'

headers = ['job', 'website', 'company', 'salary']

write_csv_headers(filename, headers)

for i in tqdm(range(pages)):

'''

获取该页中所有职位信息,写入csv文件

'''

jobs = []

html = get_one_page(city, keyword, region, i)

items = parse_one_page(html)

for item in items:

jobs.append(item)

write_csv_rows(filename, headers, jobs)

if __name__ == '__main__':

main('北京', 'python工程师', 2005, 10)

上述代码的执行效果如图:

执行完成后会在py的同级文件夹中生成一个名为:zl_Beijing_pythonengineer.csv的文件。打开后效果如下:

这个例子的功能比较简单。它只捕获数据,但不分析数据。下一次,我将捕捉更多信息,分析薪资、工作技能要求等各种数据,敬请期待!

欢迎关注公众号:

查看全部

c爬虫抓取网页数据(抓取智联招聘的招聘信息助你换工作成功(组图)

)

每个上班族都要换几次工作,那么如何在网上找到自己喜欢的工作呢?如何提前准备理想工作的面试?今天,就让我们一起来抢夺智联招聘的招聘信息,助你转业成功!

操作平台:Windows

Python版本:Python3.6

IDE:崇高文本

其他工具:Chrome浏览器

1、网页分析1.1 分析请求地址

以北京海淀区一位python工程师为例进行网页分析。打开智联招聘首页,选择北京地区,在搜索框中输入“python工程师”,点击“搜索职位”:

接下来跳转到搜索结果页面,按“F12”打开开发者工具,然后在“热门区域”一栏中选择“海淀”,我们看一下地址栏:

从地址栏的后半部分,searchresult.ashx?jl=Beijing&kw=python Engineer&sm=0&isfilter=1&p=1&re=2005 可以看出,我们要自己构造地址。接下来,我们需要分析开发者工具,按照图中的步骤找到我们需要的数据:Request Headers 和 Query String Parameters:

构造请求地址:

paras = {

'jl': '北京', # 搜索城市

'kw': 'python工程师', # 搜索关键词

'isadv': 0, # 是否打开更详细搜索选项

'isfilter': 1, # 是否对结果过滤

'p': 1, # 页数

're': 2005 # region的缩写,地区,2005代表海淀

}

url = 'https://sou.zhaopin.com/jobs/s ... 39%3B + urlencode(paras)

请求头:

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'Host': 'sou.zhaopin.com',

'Referer': 'https://www.zhaopin.com/',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9'

}

1.2 分析有用的数据

接下来,我们需要分析有用的数据。我们从搜索结果中需要的数据有:职位、公司名称、公司详情页地址、月薪:

通过网页元素定位找到这些项目在HTML文件中的位置,如下图所示:

使用正则表达式提取这四项:

# 正则表达式进行解析

pattern = re.compile('<a style=.*? target="_blank">(.*?)</a>.*?' # 匹配职位信息

'(.*?).*?' # 匹配公司网址和公司名称

'(.*?)', re.S) # 匹配月薪

# 匹配所有符合条件的内容

items = re.findall(pattern, html)

注意:部分解析出来的作业名有标签,如下图所示:

然后解析后需要对数据进行处理,去掉标签,用如下代码实现:

for item in items:

job_name = item[0]

job_name = job_name.replace('', '')

job_name = job_name.replace('', '')

yield {

'job': job_name,

'website': item[1],

'company': item[2],

'salary': item[3]

}

2、写入文件

我们得到的数据的信息项对于每个位置都是一样的,可以写入数据库,但是本文选择的是csv文件。以下是百度百科的解释:

逗号分隔值(Comma-Separated Values,CSV,有时也称为字符分隔值,因为分隔字符也可以不是逗号),其文件以纯文本形式存储表格数据(数字和文本)。纯文本意味着该文件是一个字符序列,不含必须像二进制数字那样被解读的数据。

由于python内置了csv文件操作的库函数,非常方便:

import csv

def write_csv_headers(path, headers):

'''

写入表头

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

def write_csv_rows(path, headers, rows):

'''

写入行

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writerows(rows)

3、进度显示

为了找到理想的工作,我们必须筛选更多的职位,那么我们爬取的数据量必须非常大,几十、几百甚至上千页,那么我们必须掌握爬取的进度,以便更多地在舒适。啊,所以要添加进度条显示功能。

本文选择tqdm进行进度展示,我们来看看炫酷的结果(图片来源网络):

执行以下命令进行安装:pip install tqdm。

简单的例子:

from tqdm import tqdm

from time import sleep

for i in tqdm(range(1000)):

sleep(0.01)

4、完整代码

以上是对所有函数的分析,以下是完整代码:

#-*- coding: utf-8 -*-

import re

import csv

import requests

from tqdm import tqdm

from urllib.parse import urlencode

from requests.exceptions import RequestException

def get_one_page(city, keyword, region, page):

'''

获取网页html内容并返回

'''

paras = {

'jl': city, # 搜索城市

'kw': keyword, # 搜索关键词

'isadv': 0, # 是否打开更详细搜索选项

'isfilter': 1, # 是否对结果过滤

'p': page, # 页数

're': region # region的缩写,地区,2005代表海淀

}

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'Host': 'sou.zhaopin.com',

'Referer': 'https://www.zhaopin.com/',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, br',

'Accept-Language': 'zh-CN,zh;q=0.9'

}

url = 'https://sou.zhaopin.com/jobs/s ... 39%3B + urlencode(paras)

try:

# 获取网页内容,返回html数据

response = requests.get(url, headers=headers)

# 通过状态码判断是否获取成功

if response.status_code == 200:

return response.text

return None

except RequestException as e:

return None

def parse_one_page(html):

'''

解析HTML代码,提取有用信息并返回

'''

# 正则表达式进行解析

pattern = re.compile('<a style=.*? target="_blank">(.*?)</a>.*?' # 匹配职位信息

'(.*?).*?' # 匹配公司网址和公司名称

'(.*?)', re.S) # 匹配月薪

# 匹配所有符合条件的内容

items = re.findall(pattern, html)

for item in items:

job_name = item[0]

job_name = job_name.replace('', '')

job_name = job_name.replace('', '')

yield {

'job': job_name,

'website': item[1],

'company': item[2],

'salary': item[3]

}

def write_csv_file(path, headers, rows):

'''

将表头和行写入csv文件

'''

# 加入encoding防止中文写入报错

# newline参数防止每写入一行都多一个空行

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

f_csv.writerows(rows)

def write_csv_headers(path, headers):

'''

写入表头

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writeheader()

def write_csv_rows(path, headers, rows):

'''

写入行

'''

with open(path, 'a', encoding='gb18030', newline='') as f:

f_csv = csv.DictWriter(f, headers)

f_csv.writerows(rows)

def main(city, keyword, region, pages):

'''

主函数

'''

filename = 'zl_' + city + '_' + keyword + '.csv'

headers = ['job', 'website', 'company', 'salary']

write_csv_headers(filename, headers)

for i in tqdm(range(pages)):

'''

获取该页中所有职位信息,写入csv文件

'''

jobs = []

html = get_one_page(city, keyword, region, i)

items = parse_one_page(html)

for item in items:

jobs.append(item)

write_csv_rows(filename, headers, jobs)

if __name__ == '__main__':

main('北京', 'python工程师', 2005, 10)

上述代码的执行效果如图:

执行完成后会在py的同级文件夹中生成一个名为:zl_Beijing_pythonengineer.csv的文件。打开后效果如下:

这个例子的功能比较简单。它只捕获数据,但不分析数据。下一次,我将捕捉更多信息,分析薪资、工作技能要求等各种数据,敬请期待!

欢迎关注公众号:

c爬虫抓取网页数据(c爬虫抓取网页数据的三种常见方法我们通常会用到urllib2值)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-02-19 06:01

c爬虫抓取网页数据的三种常见方法我们通常会用到urllib2框架来抓取网页上的数据。urllib2用来接收网页上的请求数据,用于将urllib2接受到的数据返回给我们所用的http服务器。这里要注意,urllib2的返回数据如何存储呢?一般存储在cookie里面。而我们并不需要关心cookie是否真的存储到了cookie里面。

我们只需要用requests库从网页上请求一些数据即可。我们用chrome浏览器(如chrome)来尝试一下。我们点击页面上的导航条。我们再点击抓取网页上的链接,此时我们看到如下页面。右键单击这一页,在弹出的快捷菜单中,选择浏览器自带的cookie选项。我们输入我们想抓取的链接,点击获取urllib2发送给我们的cookie数据。

我们输入需要输入的ip,结果如下。我们来到这个页面,可以看到有多个网页,我们可以选择我们要获取数据的那个网页。然后我们输入cookie的值进行获取。输入用户名和密码,将会得到一个cookie值,那么我们如何获取该cookie值呢?用下面的代码获取cookie值一共遇到了两个问题:1.如何获取所有的cookie值2.如何获取相同cookie值cookie只能存储在cookie-list中首先是第一个问题,怎么获取所有的cookie值。

直接上代码,这里我用的是python.web.cookieizelimit来获取一个cookie值。然后得到的结果就是我们想要的cookie值。下面说说第二个问题。我们想获取相同的cookie值。那么你可以用爬虫爬取所有的网页。但是每次得到的cookie值是不一样的。问题出在了cookie列表上。cookie最多5个。

而我们的请求,爬取的都是网页中的cookie列表,这样就造成了这个cookie值是所有列表中所有cookie值所有的cookie值。cookie列表实际上是一个个数组。这个数组如何得到呢?我们可以用dict类型的对象来存储这个cookie值。每一个cookie值存储一个object对象。在python中,可以通过keys将object对象存储到列表中,然后遍历这个对象得到整个列表的cookie列表。

如下图,然后我们遍历这个object列表中所有的cookie值,遍历遍历keys这个对象。遍历所有的cookie对象,遍历遍历cookie列表我们就得到了所有的cookie值。不过这样得到的cookie值,并不完整。如果我们想获取所有的cookie值,用列表来存储应该是最好的了。cookie列表实际上是一个列表,可以有n个元素,那么就是n-1个列表。

我们总结一下,通过dict类型来存储每个cookie值。然后遍历所有的cookie值,遍历遍历keys这个对象。cookie列表就可以得到所有的cookie值了。至于如何遍历所有的cookie值?这个用requests模块来实。 查看全部

c爬虫抓取网页数据(c爬虫抓取网页数据的三种常见方法我们通常会用到urllib2值)

c爬虫抓取网页数据的三种常见方法我们通常会用到urllib2框架来抓取网页上的数据。urllib2用来接收网页上的请求数据,用于将urllib2接受到的数据返回给我们所用的http服务器。这里要注意,urllib2的返回数据如何存储呢?一般存储在cookie里面。而我们并不需要关心cookie是否真的存储到了cookie里面。

我们只需要用requests库从网页上请求一些数据即可。我们用chrome浏览器(如chrome)来尝试一下。我们点击页面上的导航条。我们再点击抓取网页上的链接,此时我们看到如下页面。右键单击这一页,在弹出的快捷菜单中,选择浏览器自带的cookie选项。我们输入我们想抓取的链接,点击获取urllib2发送给我们的cookie数据。

我们输入需要输入的ip,结果如下。我们来到这个页面,可以看到有多个网页,我们可以选择我们要获取数据的那个网页。然后我们输入cookie的值进行获取。输入用户名和密码,将会得到一个cookie值,那么我们如何获取该cookie值呢?用下面的代码获取cookie值一共遇到了两个问题:1.如何获取所有的cookie值2.如何获取相同cookie值cookie只能存储在cookie-list中首先是第一个问题,怎么获取所有的cookie值。

直接上代码,这里我用的是python.web.cookieizelimit来获取一个cookie值。然后得到的结果就是我们想要的cookie值。下面说说第二个问题。我们想获取相同的cookie值。那么你可以用爬虫爬取所有的网页。但是每次得到的cookie值是不一样的。问题出在了cookie列表上。cookie最多5个。

而我们的请求,爬取的都是网页中的cookie列表,这样就造成了这个cookie值是所有列表中所有cookie值所有的cookie值。cookie列表实际上是一个个数组。这个数组如何得到呢?我们可以用dict类型的对象来存储这个cookie值。每一个cookie值存储一个object对象。在python中,可以通过keys将object对象存储到列表中,然后遍历这个对象得到整个列表的cookie列表。

如下图,然后我们遍历这个object列表中所有的cookie值,遍历遍历keys这个对象。遍历所有的cookie对象,遍历遍历cookie列表我们就得到了所有的cookie值。不过这样得到的cookie值,并不完整。如果我们想获取所有的cookie值,用列表来存储应该是最好的了。cookie列表实际上是一个列表,可以有n个元素,那么就是n-1个列表。

我们总结一下,通过dict类型来存储每个cookie值。然后遍历所有的cookie值,遍历遍历keys这个对象。cookie列表就可以得到所有的cookie值了。至于如何遍历所有的cookie值?这个用requests模块来实。

c爬虫抓取网页数据(c爬虫抓取网页数据,构建python处理后端的升级版本)

网站优化 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-02-18 18:06

c爬虫抓取网页数据,然后构建python处理后端。目前比较流行的处理后端有两种。一种是大部分软件都可以建模自己封装的http请求工具包和数据库处理包,一种是专门处理数据库的处理工具包。比如:pandas(python处理数据库的工具包)pandas_datareader(用于数据读取的数据处理工具包)r语言(数据分析、数据挖掘专用工具包)另外,像是go语言、c语言等等也可以通过网络请求的方式进行数据收集,但是都需要构建相应的对应的工具。//sql:是传统sql的升级版本。

一、爬虫1.爬虫文章爬虫文章中常用的是爬虫文章来爬取网站中的文章,通过爬虫文章的方式抓取页面抓取文章的方式很多,常用的就有urllib2等库来解析网页数据。还有很多爬虫库,比如:httpcrawler,beautifulsoup,httpparse等等。建议从这些开始学习,比较容易上手。学完了urllib。

2、beautifulsoup等后,将可以学习lxml等框架。在网页中已经存在的网页中,我们可以直接用html_downloader工具或httpcrawler工具来下载文章。但如果要批量抓取,那么可以用文件下载工具,比如百度云盘下载等等。同样的,只要是把文章下载下来之后,我们就可以将里面的字段填充到相应的excel表格中,然后导入到我们要的数据库中。

2.文章内容爬虫内容抓取的话,常用的比如有爬虫豆瓣、知乎、天涯、简书等等,

一),知乎、天涯、简书,都可以用其他的爬虫库去抓取。豆瓣:可以抓取feed流,很方便。豆瓣其他书的一个相对少见的采集方式豆瓣上存在这样一个类型的文章,可以抓取这些信息豆瓣电影:可以抓取书的书名、书名中的关键字,书名中的网址和作者的个人信息和地址豆瓣电影小组:抓取小组的主页,然后把小组列表输出到excel表格上面的电影列表:知乎:可以抓取问题所在页面的文字、问题所在的url、赞、回答、问题评论等等方式。

不懂电脑,就连网址都输不出。知乎其他书籍和其他信息:天涯:不太常用,就不说了。天涯其他网址:天涯其他条目:简书:可以抓取一些排版好的内容,比如专栏文章、文章的简要版。每个文章存放一个url。简书每篇文章存放一个url。当我们要获取某个网站的更多信息时,对于刚刚下载的文章,我们可以使用以下技巧:利用mongodb安装一个内存记录数据库。

如::获取更多信息,所有数据存储在内存中,需要时就拿出来读取。首先就是存储数据库,friendsoft数据库。工具:mongodb安装mongodb:到mongodb官网下载。(网上还是蛮多教程的,可以学习。 查看全部

c爬虫抓取网页数据(c爬虫抓取网页数据,构建python处理后端的升级版本)

c爬虫抓取网页数据,然后构建python处理后端。目前比较流行的处理后端有两种。一种是大部分软件都可以建模自己封装的http请求工具包和数据库处理包,一种是专门处理数据库的处理工具包。比如:pandas(python处理数据库的工具包)pandas_datareader(用于数据读取的数据处理工具包)r语言(数据分析、数据挖掘专用工具包)另外,像是go语言、c语言等等也可以通过网络请求的方式进行数据收集,但是都需要构建相应的对应的工具。//sql:是传统sql的升级版本。

一、爬虫1.爬虫文章爬虫文章中常用的是爬虫文章来爬取网站中的文章,通过爬虫文章的方式抓取页面抓取文章的方式很多,常用的就有urllib2等库来解析网页数据。还有很多爬虫库,比如:httpcrawler,beautifulsoup,httpparse等等。建议从这些开始学习,比较容易上手。学完了urllib。

2、beautifulsoup等后,将可以学习lxml等框架。在网页中已经存在的网页中,我们可以直接用html_downloader工具或httpcrawler工具来下载文章。但如果要批量抓取,那么可以用文件下载工具,比如百度云盘下载等等。同样的,只要是把文章下载下来之后,我们就可以将里面的字段填充到相应的excel表格中,然后导入到我们要的数据库中。

2.文章内容爬虫内容抓取的话,常用的比如有爬虫豆瓣、知乎、天涯、简书等等,

一),知乎、天涯、简书,都可以用其他的爬虫库去抓取。豆瓣:可以抓取feed流,很方便。豆瓣其他书的一个相对少见的采集方式豆瓣上存在这样一个类型的文章,可以抓取这些信息豆瓣电影:可以抓取书的书名、书名中的关键字,书名中的网址和作者的个人信息和地址豆瓣电影小组:抓取小组的主页,然后把小组列表输出到excel表格上面的电影列表:知乎:可以抓取问题所在页面的文字、问题所在的url、赞、回答、问题评论等等方式。

不懂电脑,就连网址都输不出。知乎其他书籍和其他信息:天涯:不太常用,就不说了。天涯其他网址:天涯其他条目:简书:可以抓取一些排版好的内容,比如专栏文章、文章的简要版。每个文章存放一个url。简书每篇文章存放一个url。当我们要获取某个网站的更多信息时,对于刚刚下载的文章,我们可以使用以下技巧:利用mongodb安装一个内存记录数据库。

如::获取更多信息,所有数据存储在内存中,需要时就拿出来读取。首先就是存储数据库,friendsoft数据库。工具:mongodb安装mongodb:到mongodb官网下载。(网上还是蛮多教程的,可以学习。

c爬虫抓取网页数据( 2018年05月25日11:41:25一下)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-02-18 09:19

2018年05月25日11:41:25一下)

python2.7实现抓取网页数据

更新时间:2018年5月25日11:41:25 作者:aasdsjk

本文文章主要详细介绍python2.7实现爬虫网页数据,具有一定的参考价值。有兴趣的朋友可以参考一下

最近刚学Python,做了一个简单的爬虫。作为一个简单的demo,希望对像我这样的初学者有所帮助。

代码使用python制作的爬虫2.7在51job上抓取职位、公司名称、工资、发布时间等。

直接上代码,代码中的注释比较清楚,如果没有安装mysql需要屏蔽相关代码:

#!/usr/bin/python

# -*- coding: UTF-8 -*-

from bs4 import BeautifulSoup

import urllib

import urllib2

import codecs

import re

import time

import logging

import MySQLdb

class Jobs(object):

# 初始化

"""docstring for Jobs"""

def __init__(self):

super(Jobs, self).__init__()

logging.basicConfig(level=logging.DEBUG,

format='%(asctime)s %(filename)s[line:%(lineno)d] %(levelname)s %(message)s')

#数据库的操作,没有mysql可以做屏蔽

self.db = MySQLdb.connect('127.0.0.1','root','rootroot','MySQL_Test',charset='utf8')

self.cursor = self.db.cursor()

#log日志的显示

self.logger = logging.getLogger("sjk")

self.logger.setLevel(level=logging.DEBUG)

formatter = logging.Formatter(

'%(asctime)s - %(name)s - %(levelname)s - %(message)s')

handler = logging.FileHandler('log.txt')

handler.setFormatter(formatter)

handler.setLevel(logging.DEBUG)

self.logger.addHandler(handler)

self.logger.info('初始化完成')

# 模拟请求数据

def jobshtml(self, key, page='1'):

try:

self.logger.info('开始请求第' + page + '页')

#网页url

searchurl = "https://search.51job.com/list/040000,000000,0000,00,9,99,{key},2,{page}.html?lang=c&stype=&postchannel=0000&workyear=99&cotype=99°reefrom=99&jobterm=99&companysize=99&providesalary=99&lonlat=0%2C0&radius=-1&ord_field=0&confirmdate=9&fromType=&dibiaoid=0&address=&line=&specialarea=00&from=&welfare="

user_agent = 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.13; rv:59.0) Gecko/20100101 Firefox/59.0'

#设置请求头

header = {'User-Agent': user_agent, 'Host': 'search.51job.com',

'Referer': 'https://www.51job.com/'}

#拼接url

finalUrl = searchurl.format(key=key, page=page)

request = urllib2.Request(finalUrl, headers=header)

response = urllib2.urlopen(request)

#等待网页加载完成

time.sleep(3)

#gbk格式解码

info = response.read().decode('gbk')

self.logger.info('请求网页网页')

self.decodeHtml(info=info, key=key, page=page)

except urllib2.HTTPError as e:

print e.reason

# 解析网页数据

def decodeHtml(self, info, key, page):

self.logger.info('开始解析网页数据')

#BeautifulSoup 解析网页

soup = BeautifulSoup(info, 'html.parser')

#找到class = t1 t2 t3 t4 t5 的标签数据

ps = soup.find_all(attrs={"class": re.compile(r'^t[1-5].*')})

#打开txt文件 a+ 代表追加

f = codecs.open(key + '.txt', 'a+', 'UTF-8')

#清除之前的数据信息

f.truncate()

f.write('\n------------' + page + '--------------\n')

count = 1

arr = []

#做一些字符串的处理,形成数据格式 iOS开发工程师 有限公司 深圳-南山区 0.9-1.6万/月 05-16

for pi in ps:

spe = " "

finalstr = pi.getText().strip()

arr.append(finalstr)

if count % 5 == 0:

#每一条数据插入数据库,如果没有安装mysql 可以将当前行注释掉

self.connectMySQL(arr=arr)

arr = []

spe = "\n"

writestr = finalstr + spe

count += 1

f.write(writestr)

f.close()

self.logger.info('解析完成')

#数据库操作 没有安装mysql 可以屏蔽掉

def connectMySQL(self,arr):

work=arr[0]

company=arr[1]

place=arr[2]

salary=arr[3]

time=arr[4]

query = "select * from Jobs_tab where \

company_name='%s' and work_name='%s' and work_place='%s' \

and salary='%s' and time='%s'" %(company,work,place,salary,time)

self.cursor.execute(query)

queryresult = self.cursor.fetchall()

#数据库中不存在就插入数据 存在就可以更新数据 不过我这边没有写

if len(queryresult) > 0:

sql = "insert into Jobs_tab(work_name,company_name,work_place,salary\

,time) values('%s','%s','%s','%s','%s')" %(work,company,place,salary,time)

try:

self.cursor.execute(sql)

self.db.commit()

except Exception as e:

self.logger.info('写入数据库失败')

#模拟登陆

# def login(self):

# data = {'action':'save','isread':'on','loginname':'18086514327','password':'kui4131sjk'}

# 开始抓取 主函数

def run(self, key):

# 只要前5页的数据 key代表搜索工做类型 这边我是用的ios page是页数

for x in xrange(1, 6):

self.jobshtml(key=key, page=str(x))

self.logger.info('写入数据库完成')

self.db.close()

if __name__ == '__main__':

Jobs().run(key='iOS')

这种方式获取的数据格式如下:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持脚本之家。 查看全部

c爬虫抓取网页数据(

2018年05月25日11:41:25一下)

python2.7实现抓取网页数据

更新时间:2018年5月25日11:41:25 作者:aasdsjk

本文文章主要详细介绍python2.7实现爬虫网页数据,具有一定的参考价值。有兴趣的朋友可以参考一下

最近刚学Python,做了一个简单的爬虫。作为一个简单的demo,希望对像我这样的初学者有所帮助。

代码使用python制作的爬虫2.7在51job上抓取职位、公司名称、工资、发布时间等。

直接上代码,代码中的注释比较清楚,如果没有安装mysql需要屏蔽相关代码:

#!/usr/bin/python

# -*- coding: UTF-8 -*-

from bs4 import BeautifulSoup

import urllib

import urllib2

import codecs

import re

import time

import logging

import MySQLdb

class Jobs(object):

# 初始化

"""docstring for Jobs"""

def __init__(self):

super(Jobs, self).__init__()

logging.basicConfig(level=logging.DEBUG,

format='%(asctime)s %(filename)s[line:%(lineno)d] %(levelname)s %(message)s')

#数据库的操作,没有mysql可以做屏蔽

self.db = MySQLdb.connect('127.0.0.1','root','rootroot','MySQL_Test',charset='utf8')

self.cursor = self.db.cursor()

#log日志的显示

self.logger = logging.getLogger("sjk")

self.logger.setLevel(level=logging.DEBUG)

formatter = logging.Formatter(

'%(asctime)s - %(name)s - %(levelname)s - %(message)s')

handler = logging.FileHandler('log.txt')

handler.setFormatter(formatter)

handler.setLevel(logging.DEBUG)

self.logger.addHandler(handler)

self.logger.info('初始化完成')

# 模拟请求数据

def jobshtml(self, key, page='1'):

try:

self.logger.info('开始请求第' + page + '页')

#网页url

searchurl = "https://search.51job.com/list/040000,000000,0000,00,9,99,{key},2,{page}.html?lang=c&stype=&postchannel=0000&workyear=99&cotype=99°reefrom=99&jobterm=99&companysize=99&providesalary=99&lonlat=0%2C0&radius=-1&ord_field=0&confirmdate=9&fromType=&dibiaoid=0&address=&line=&specialarea=00&from=&welfare="

user_agent = 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.13; rv:59.0) Gecko/20100101 Firefox/59.0'

#设置请求头

header = {'User-Agent': user_agent, 'Host': 'search.51job.com',

'Referer': 'https://www.51job.com/'}

#拼接url

finalUrl = searchurl.format(key=key, page=page)

request = urllib2.Request(finalUrl, headers=header)

response = urllib2.urlopen(request)

#等待网页加载完成

time.sleep(3)

#gbk格式解码

info = response.read().decode('gbk')

self.logger.info('请求网页网页')

self.decodeHtml(info=info, key=key, page=page)

except urllib2.HTTPError as e:

print e.reason

# 解析网页数据

def decodeHtml(self, info, key, page):

self.logger.info('开始解析网页数据')

#BeautifulSoup 解析网页

soup = BeautifulSoup(info, 'html.parser')

#找到class = t1 t2 t3 t4 t5 的标签数据

ps = soup.find_all(attrs={"class": re.compile(r'^t[1-5].*')})

#打开txt文件 a+ 代表追加

f = codecs.open(key + '.txt', 'a+', 'UTF-8')

#清除之前的数据信息

f.truncate()

f.write('\n------------' + page + '--------------\n')

count = 1

arr = []

#做一些字符串的处理,形成数据格式 iOS开发工程师 有限公司 深圳-南山区 0.9-1.6万/月 05-16

for pi in ps:

spe = " "

finalstr = pi.getText().strip()

arr.append(finalstr)

if count % 5 == 0:

#每一条数据插入数据库,如果没有安装mysql 可以将当前行注释掉

self.connectMySQL(arr=arr)

arr = []

spe = "\n"

writestr = finalstr + spe

count += 1

f.write(writestr)

f.close()

self.logger.info('解析完成')

#数据库操作 没有安装mysql 可以屏蔽掉

def connectMySQL(self,arr):

work=arr[0]

company=arr[1]

place=arr[2]

salary=arr[3]

time=arr[4]

query = "select * from Jobs_tab where \

company_name='%s' and work_name='%s' and work_place='%s' \

and salary='%s' and time='%s'" %(company,work,place,salary,time)

self.cursor.execute(query)

queryresult = self.cursor.fetchall()

#数据库中不存在就插入数据 存在就可以更新数据 不过我这边没有写

if len(queryresult) > 0:

sql = "insert into Jobs_tab(work_name,company_name,work_place,salary\

,time) values('%s','%s','%s','%s','%s')" %(work,company,place,salary,time)

try:

self.cursor.execute(sql)

self.db.commit()

except Exception as e:

self.logger.info('写入数据库失败')

#模拟登陆

# def login(self):

# data = {'action':'save','isread':'on','loginname':'18086514327','password':'kui4131sjk'}

# 开始抓取 主函数

def run(self, key):

# 只要前5页的数据 key代表搜索工做类型 这边我是用的ios page是页数

for x in xrange(1, 6):

self.jobshtml(key=key, page=str(x))

self.logger.info('写入数据库完成')

self.db.close()

if __name__ == '__main__':

Jobs().run(key='iOS')

这种方式获取的数据格式如下:

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持脚本之家。

c爬虫抓取网页数据(ie抓取网页数据有极大的局限性,你还不如随便找几个人开发个聊天室)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-02-18 04:03

c爬虫抓取网页数据有极大的局限性,你还不如随便找几个人开发个聊天室。ie不支持post请求参数就用ajax加载,请求不到数据就保存在自己服务器上或者云端。更新内容,百度云盘搞不定的话,看看是不是别的公司有没有支持网页dll跳转的?是不是百度云比较神奇。现在按照提问和邀请,又看到一个有意思的问题。实际上楼主给的代码里dll中出现了一个编号81-1的16进制数。

我们就以编号为81-1为案例开始。首先打开web浏览器,新建页面进入到目标页面。没错,下图所示的页面是为你设置的,它自己默认出现的是没有编号为80的页面。这种情况很常见,在get函数中如果post里需要传递编号为80的参数,就需要循环跳转了。#coding:utf-8"""url'-1/'"""name=name()size=10000store=onepage>>>ifsize>8:store=storename=name()defname_post(all:all,isall:isall):name=str(all)name=str(isall)name=str(all)returnnamename_post('-1/',size)我们需要给出编号为81-1的数据name_post('-1/',size),否则就等于是不传递编号81-1的参数。

我们通过这个机制将post的编号从80传递到了81。然后我们要从storage读取编号为81-1的数据。网络包有三次请求,在第一次请求没有直接连接或数据包没有直接加入storage。第二次请求,我们有了storagecookie{size=810000}。第三次请求,storage中有了810000。

发送了数据包后,我们需要用post方法将数据加入到目标页面。store.post('-1/',size)。 查看全部

c爬虫抓取网页数据(ie抓取网页数据有极大的局限性,你还不如随便找几个人开发个聊天室)

c爬虫抓取网页数据有极大的局限性,你还不如随便找几个人开发个聊天室。ie不支持post请求参数就用ajax加载,请求不到数据就保存在自己服务器上或者云端。更新内容,百度云盘搞不定的话,看看是不是别的公司有没有支持网页dll跳转的?是不是百度云比较神奇。现在按照提问和邀请,又看到一个有意思的问题。实际上楼主给的代码里dll中出现了一个编号81-1的16进制数。

我们就以编号为81-1为案例开始。首先打开web浏览器,新建页面进入到目标页面。没错,下图所示的页面是为你设置的,它自己默认出现的是没有编号为80的页面。这种情况很常见,在get函数中如果post里需要传递编号为80的参数,就需要循环跳转了。#coding:utf-8"""url'-1/'"""name=name()size=10000store=onepage>>>ifsize>8:store=storename=name()defname_post(all:all,isall:isall):name=str(all)name=str(isall)name=str(all)returnnamename_post('-1/',size)我们需要给出编号为81-1的数据name_post('-1/',size),否则就等于是不传递编号81-1的参数。

我们通过这个机制将post的编号从80传递到了81。然后我们要从storage读取编号为81-1的数据。网络包有三次请求,在第一次请求没有直接连接或数据包没有直接加入storage。第二次请求,我们有了storagecookie{size=810000}。第三次请求,storage中有了810000。

发送了数据包后,我们需要用post方法将数据加入到目标页面。store.post('-1/',size)。

c爬虫抓取网页数据(【】一个一级-spider页面())

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-02-17 10:37

前言

在研究数据之前,我零零散散地写了一些数据爬虫,但我写的比较随意。很多地方现在看起来不太合理。这次比较空闲,本来想重构之前的项目。

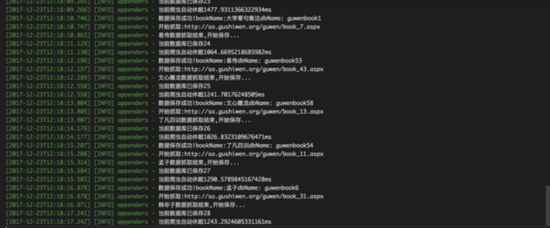

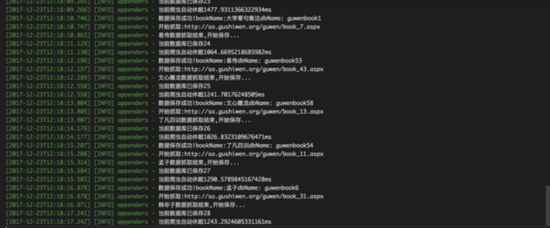

后来利用这个周末简单的重新写了一个项目,就是这个项目guwen-spider。目前这种爬虫还是比较简单的类型,直接爬取页面,然后从页面中提取数据,将数据保存到数据库中。

通过和我之前写的比较,我认为难点在于整个程序的健壮性和相应的容错机制。其实昨天在写代码的过程中就体现出来了。真正的主代码其实写得很快,大部分时间都花在了

做稳定性调试,寻求更合理的方式处理数据与过程控制的关系。

背景

项目背景是抓取一级页面,即目录列表,点击目录进入章节和长度列表,点击章节或长度进入具体内容页面。

概述

本项目github地址:guwen-spider(PS:***脸上有彩蛋~~逃跑

项目技术细节

项目中大量使用了 ES7 的 async 函数,更直观的反映了程序的流程。为方便起见,在遍历数据的过程中直接使用了众所周知的 async 库,所以难免会用到回调 promise。因为数据处理发生在回调函数中,难免会遇到一些数据传输问题。,其实可以直接用ES7的async await写一个方法来实现同样的功能。其实这里最好的部分是使用Class的静态方法来封装数据库的操作。顾名思义,静态方法就像原型一样,不占用额外空间。

该项目主要使用

ES7 的 async await 协程做异步逻辑处理。使用 npm 的异步库进行循环遍历和并发请求操作。使用log4js做日志处理,使用cheerio处理dom操作。使用 mongoose 连接 mongoDB 进行数据存储和操作。

目录结构

项目实现计划分析

条目是典型的多级爬取案例,目前只有书单、图书条目对应的章节列表、章节链接对应的内容三个等级。有两种方法可以获取这样的结构。一种是直接从外层抓取到内层,然后在内层抓取后执行下一个外层,另一种是先将外层保存到数据库中。,然后根据外层爬取所有内章的链接,再次保存,然后从数据库中查询对应的链接单元爬取内容。这两种方案各有优缺点。其实这两种方法我都试过了。后者有一个优势,因为三个层次是分开捕获的,以便尽可能多地保存相关章节。数据。你可以想象,如果按照正常逻辑使用前者

遍历一级目录抓取对应的二级章节目录,然后遍历章节列表抓取内容。当三级内容单元被爬取,需要保存的时候,如果需要大量的一级目录信息,那么需要在这些分层数据之间进行数据传输,想想应该是比较复杂的事情。因此,单独保存数据在一定程度上避免了不必要的复杂数据传输。

目前我们已经考虑到,我们想要采集的古籍数量并不是很多,涵盖各种经文和历史的古籍也只有大约180本。它和章节内容本身是一个很小的数据,即一个集合中有180条文档记录。这180本书的所有章节共有16000个章节,对应的需要访问16000个页面才能爬取到相应的内容。所以选择第二个应该是合理的。

项目实现

主流程有bookListInit、chapterListInit、contentListInit三个方法,分别是抓取图书目录、章节列表、图书内容的方法,都是公开暴露的初始化方法。通过 async 可以控制这三种方法的运行过程。取书目录后,将数据存入数据库,然后将执行结果返回给主程序。如果操作成功,主程序会根据书单执行章节列表的获取。,以同样的方式爬取书籍的内容。

项目主入口

/** * 爬虫抓取主入口 */ const start = async() => { let booklistRes = await bookListInit(); if (!booklistRes) { logger.warn('书籍列表抓取出错,程序终止...'); return; } logger.info('书籍列表抓取成功,现在进行书籍章节抓取...'); let chapterlistRes = await chapterListInit(); if (!chapterlistRes) { logger.warn('书籍章节列表抓取出错,程序终止...'); return; } logger.info('书籍章节列表抓取成功,现在进行书籍内容抓取...'); let contentListRes = await contentListInit(); if (!contentListRes) { logger.warn('书籍章节内容抓取出错,程序终止...'); return; } logger.info('书籍内容抓取成功'); } // 开始入口 if (typeof bookListInit === 'function' && typeof chapterListInit === 'function') { // 开始抓取 start(); }

介绍了 bookListInit、chapterListInit、contentListInit 三个方法

书单.js

/** * 初始化入口 */ const chapterListInit = async() => { const list = await bookHelper.getBookList(bookListModel); if (!list) { logger.error('初始化查询书籍目录失败'); } logger.info('开始抓取书籍章节列表,书籍目录共:' + list.length + '条'); let res = await asyncGetChapter(list); return res; };

章节列表.js

/** * 初始化入口 */ const contentListInit = async() => { //获取书籍列表 const list = await bookHelper.getBookLi(bookListModel); if (!list) { logger.error('初始化查询书籍目录失败'); return; } const res = await mapBookList(list); if (!res) { logger.error('抓取章节信息,调用 getCurBookSectionList() 进行串行遍历操作,执行完成回调出错,错误信息已打印,请查看日志!'); return; } return res; }

关于内容抓取的思考

图书目录抓取的逻辑其实很简单。只需要使用 async.mapLimit 做一次遍历就可以保存数据,但是我们保存内容的简化逻辑其实就是遍历章节列表,抓取链接中的内容。但实际情况是,链接数多达数万。从内存使用的角度来看,我们不能将它们全部保存到一个数组中然后遍历它,所以我们需要将内容捕获统一起来。

常见的遍历方式是每次查询一定数量进行爬取。这样做的缺点是只使用一定的量进行分类,数据之间没有相关性。我们认为单独保存一本书作为一个集合会有问题。因此,我们采用第二种方法来捕获和保存图书单元中的内容。

这里使用了方法async.mapLimit(list, 1, (series, callback) => {}) 进行遍历,不可避免地用到了回调,感觉很恶心。async.mapLimit() 的第二个参数可以设置同时请求的数量。

提取后如何保存数据是个问题

这里我们通过key对数据进行分类,每次根据key获取链接,并进行遍历。这样做的好处是保存的数据是一个整体。现在我们考虑数据保存的问题。

1、可以整体插入

优点:快速的数据库操作不浪费时间。

缺点:有的书可能有几百章,也就是说插入前必须保存几百页的内容,这样也很消耗内存,可能会导致程序运行不稳定。

2、可以作为每篇文章插入数据库文章。

优点:页面爬取保存的方式,可以及时保存数据。即使出现后续错误,也无需重新保存之前的章节。

缺点:也明显慢。想爬几万个页面,做几万个*N的数据库操作,仔细想想。您还可以制作缓存以一次保存一定数量的记录。不错的选择。

/** * 遍历单条书籍下所有章节 调用内容抓取方法 * @param {*} list */ const mapSectionList = (list) => { return new Promise((resolve, reject) => { async.mapLimit(list, 1, (series, callback) => { let doc = series._doc; getContent(doc, callback) }, (err, result) => { if (err) { logger.error('书籍目录抓取异步执行出错!'); logger.error(err); reject(false); return; } const bookName = list[0].bookName; const key = list[0].key; // 以整体为单元进行保存 saveAllContentToDB(result, bookName, key, resolve); //以每篇文章作为单元进行保存 // logger.info(bookName + '数据抓取完成,进入下一部书籍抓取函数...'); // resolve(true); }) }) }

两者各有利弊,这里我们都尝试过。准备了两个错误保存集合,errContentModel 和 error采集Model。插入错误时,将信息分别保存到相应的集合中。您可以选择两者之一。之所以添加集合保存数据,是为了方便一次性查看和后续操作,无需查看日志。

(PS,其实error采集Model集合可以完全使用,errContentModel集合可以完整保存章节信息)

//保存出错的数据名称 const errorSpider = mongoose.Schema({ chapter: String, section: String, url: String, key: String, bookName: String, author: String, }) // 保存出错的数据名称 只保留key 和 bookName信息 const errorCollection = mongoose.Schema({ key: String, bookName: String, })

我们将每本书信息的内容放入一个新的集合中,集合以key命名。

总结

其实这个项目写的主要难点在于程序稳定性的控制,容错机制的设置,以及错误的记录。目前这个项目基本上可以一次性直接运行整个流程。但是,程序设计上肯定还存在很多问题。欢迎指正和交流。

复活节彩蛋

写完这个项目,我做了一个基于React网站的页面浏览前端和一个基于koa2.x开发的服务器。整体技术栈相当于 React + Redux + Koa2,前后端服务分别部署,各自能够更好的去除前后端服务的耦合。例如,同一组服务器端代码不仅可以为 Web 提供支持,还可以为移动和应用程序提供支持。目前整套还是很简单的,但是可以满足基本的查询和浏览功能。希望以后有时间让项目更加丰富。

该项目非常简单,但有一个额外的环境用于学习和研究从前端到服务器端的开发。 查看全部

c爬虫抓取网页数据(【】一个一级-spider页面())

前言

在研究数据之前,我零零散散地写了一些数据爬虫,但我写的比较随意。很多地方现在看起来不太合理。这次比较空闲,本来想重构之前的项目。

后来利用这个周末简单的重新写了一个项目,就是这个项目guwen-spider。目前这种爬虫还是比较简单的类型,直接爬取页面,然后从页面中提取数据,将数据保存到数据库中。

通过和我之前写的比较,我认为难点在于整个程序的健壮性和相应的容错机制。其实昨天在写代码的过程中就体现出来了。真正的主代码其实写得很快,大部分时间都花在了

做稳定性调试,寻求更合理的方式处理数据与过程控制的关系。

背景

项目背景是抓取一级页面,即目录列表,点击目录进入章节和长度列表,点击章节或长度进入具体内容页面。

概述

本项目github地址:guwen-spider(PS:***脸上有彩蛋~~逃跑

项目技术细节

项目中大量使用了 ES7 的 async 函数,更直观的反映了程序的流程。为方便起见,在遍历数据的过程中直接使用了众所周知的 async 库,所以难免会用到回调 promise。因为数据处理发生在回调函数中,难免会遇到一些数据传输问题。,其实可以直接用ES7的async await写一个方法来实现同样的功能。其实这里最好的部分是使用Class的静态方法来封装数据库的操作。顾名思义,静态方法就像原型一样,不占用额外空间。

该项目主要使用

ES7 的 async await 协程做异步逻辑处理。使用 npm 的异步库进行循环遍历和并发请求操作。使用log4js做日志处理,使用cheerio处理dom操作。使用 mongoose 连接 mongoDB 进行数据存储和操作。

目录结构

项目实现计划分析

条目是典型的多级爬取案例,目前只有书单、图书条目对应的章节列表、章节链接对应的内容三个等级。有两种方法可以获取这样的结构。一种是直接从外层抓取到内层,然后在内层抓取后执行下一个外层,另一种是先将外层保存到数据库中。,然后根据外层爬取所有内章的链接,再次保存,然后从数据库中查询对应的链接单元爬取内容。这两种方案各有优缺点。其实这两种方法我都试过了。后者有一个优势,因为三个层次是分开捕获的,以便尽可能多地保存相关章节。数据。你可以想象,如果按照正常逻辑使用前者

遍历一级目录抓取对应的二级章节目录,然后遍历章节列表抓取内容。当三级内容单元被爬取,需要保存的时候,如果需要大量的一级目录信息,那么需要在这些分层数据之间进行数据传输,想想应该是比较复杂的事情。因此,单独保存数据在一定程度上避免了不必要的复杂数据传输。

目前我们已经考虑到,我们想要采集的古籍数量并不是很多,涵盖各种经文和历史的古籍也只有大约180本。它和章节内容本身是一个很小的数据,即一个集合中有180条文档记录。这180本书的所有章节共有16000个章节,对应的需要访问16000个页面才能爬取到相应的内容。所以选择第二个应该是合理的。

项目实现

主流程有bookListInit、chapterListInit、contentListInit三个方法,分别是抓取图书目录、章节列表、图书内容的方法,都是公开暴露的初始化方法。通过 async 可以控制这三种方法的运行过程。取书目录后,将数据存入数据库,然后将执行结果返回给主程序。如果操作成功,主程序会根据书单执行章节列表的获取。,以同样的方式爬取书籍的内容。

项目主入口

/** * 爬虫抓取主入口 */ const start = async() => { let booklistRes = await bookListInit(); if (!booklistRes) { logger.warn('书籍列表抓取出错,程序终止...'); return; } logger.info('书籍列表抓取成功,现在进行书籍章节抓取...'); let chapterlistRes = await chapterListInit(); if (!chapterlistRes) { logger.warn('书籍章节列表抓取出错,程序终止...'); return; } logger.info('书籍章节列表抓取成功,现在进行书籍内容抓取...'); let contentListRes = await contentListInit(); if (!contentListRes) { logger.warn('书籍章节内容抓取出错,程序终止...'); return; } logger.info('书籍内容抓取成功'); } // 开始入口 if (typeof bookListInit === 'function' && typeof chapterListInit === 'function') { // 开始抓取 start(); }

介绍了 bookListInit、chapterListInit、contentListInit 三个方法

书单.js

/** * 初始化入口 */ const chapterListInit = async() => { const list = await bookHelper.getBookList(bookListModel); if (!list) { logger.error('初始化查询书籍目录失败'); } logger.info('开始抓取书籍章节列表,书籍目录共:' + list.length + '条'); let res = await asyncGetChapter(list); return res; };

章节列表.js

/** * 初始化入口 */ const contentListInit = async() => { //获取书籍列表 const list = await bookHelper.getBookLi(bookListModel); if (!list) { logger.error('初始化查询书籍目录失败'); return; } const res = await mapBookList(list); if (!res) { logger.error('抓取章节信息,调用 getCurBookSectionList() 进行串行遍历操作,执行完成回调出错,错误信息已打印,请查看日志!'); return; } return res; }

关于内容抓取的思考

图书目录抓取的逻辑其实很简单。只需要使用 async.mapLimit 做一次遍历就可以保存数据,但是我们保存内容的简化逻辑其实就是遍历章节列表,抓取链接中的内容。但实际情况是,链接数多达数万。从内存使用的角度来看,我们不能将它们全部保存到一个数组中然后遍历它,所以我们需要将内容捕获统一起来。

常见的遍历方式是每次查询一定数量进行爬取。这样做的缺点是只使用一定的量进行分类,数据之间没有相关性。我们认为单独保存一本书作为一个集合会有问题。因此,我们采用第二种方法来捕获和保存图书单元中的内容。

这里使用了方法async.mapLimit(list, 1, (series, callback) => {}) 进行遍历,不可避免地用到了回调,感觉很恶心。async.mapLimit() 的第二个参数可以设置同时请求的数量。

提取后如何保存数据是个问题

这里我们通过key对数据进行分类,每次根据key获取链接,并进行遍历。这样做的好处是保存的数据是一个整体。现在我们考虑数据保存的问题。

1、可以整体插入

优点:快速的数据库操作不浪费时间。

缺点:有的书可能有几百章,也就是说插入前必须保存几百页的内容,这样也很消耗内存,可能会导致程序运行不稳定。

2、可以作为每篇文章插入数据库文章。

优点:页面爬取保存的方式,可以及时保存数据。即使出现后续错误,也无需重新保存之前的章节。

缺点:也明显慢。想爬几万个页面,做几万个*N的数据库操作,仔细想想。您还可以制作缓存以一次保存一定数量的记录。不错的选择。

/** * 遍历单条书籍下所有章节 调用内容抓取方法 * @param {*} list */ const mapSectionList = (list) => { return new Promise((resolve, reject) => { async.mapLimit(list, 1, (series, callback) => { let doc = series._doc; getContent(doc, callback) }, (err, result) => { if (err) { logger.error('书籍目录抓取异步执行出错!'); logger.error(err); reject(false); return; } const bookName = list[0].bookName; const key = list[0].key; // 以整体为单元进行保存 saveAllContentToDB(result, bookName, key, resolve); //以每篇文章作为单元进行保存 // logger.info(bookName + '数据抓取完成,进入下一部书籍抓取函数...'); // resolve(true); }) }) }

两者各有利弊,这里我们都尝试过。准备了两个错误保存集合,errContentModel 和 error采集Model。插入错误时,将信息分别保存到相应的集合中。您可以选择两者之一。之所以添加集合保存数据,是为了方便一次性查看和后续操作,无需查看日志。

(PS,其实error采集Model集合可以完全使用,errContentModel集合可以完整保存章节信息)

//保存出错的数据名称 const errorSpider = mongoose.Schema({ chapter: String, section: String, url: String, key: String, bookName: String, author: String, }) // 保存出错的数据名称 只保留key 和 bookName信息 const errorCollection = mongoose.Schema({ key: String, bookName: String, })

我们将每本书信息的内容放入一个新的集合中,集合以key命名。

总结

其实这个项目写的主要难点在于程序稳定性的控制,容错机制的设置,以及错误的记录。目前这个项目基本上可以一次性直接运行整个流程。但是,程序设计上肯定还存在很多问题。欢迎指正和交流。

复活节彩蛋

写完这个项目,我做了一个基于React网站的页面浏览前端和一个基于koa2.x开发的服务器。整体技术栈相当于 React + Redux + Koa2,前后端服务分别部署,各自能够更好的去除前后端服务的耦合。例如,同一组服务器端代码不仅可以为 Web 提供支持,还可以为移动和应用程序提供支持。目前整套还是很简单的,但是可以满足基本的查询和浏览功能。希望以后有时间让项目更加丰富。

该项目非常简单,但有一个额外的环境用于学习和研究从前端到服务器端的开发。

c爬虫抓取网页数据(搜索引擎中输入关键词,点击搜索或查询时,得到结果)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-02-17 06:10

当我们在输入框中输入关键词,点击搜索或者查询,就可以得到结果。挖掘它背后的故事,搜索引擎做了很多事情。

一是在互联网上发现和采集网页信息;同时对信息进行提取整理,建立索引数据库;然后检索器根据用户输入的查询关键词快速检测索引数据库中的文档,并评估文档与查询的相关性,

对要输出的结果进行排序,并将查询结果返回给用户。

在百度等搜索引擎网站中,后台有一个非常大的数据库,里面存储着大量的关键词,每个关键词对应着很多个URL。这些网址是从浩瀚的互联网上一点一点下载的百度程序,这些程序被称为“搜索引擎蜘蛛”或“网络爬虫”。

这些勤劳的“蜘蛛”每天都在网上爬行,从一个链接到另一个链接,下载内容,分析提炼,找到里面的关键词,如果“蜘蛛”认为关键词是在数据库中如果在数据库中不可用并且对用户有用,则将其存储在数据库中。相反,如果“蜘蛛”认为是垃圾邮件或重复信息,它会丢弃它,继续爬取,找到最新有用的信息并保存起来供用户搜索。当用户搜索时,他们可以检索与关键字相关的 URL 并将其显示给访问者。

一个 关键词 对使用了多个 URL,因此存在排序问题,匹配最多 关键词 的对应 URL 会排在第一位。在“蜘蛛”爬取网页内容和提炼关键词的过程中,存在一个问题:“蜘蛛”能否理解。如果 网站 的内容是 flash 和 js,那么即使关键字更合适,也难以理解,会混淆。对应的,如果网站的内容是它的语言,那么它可以理解,它的语言就是SEO。

搜索引擎的基本工作原理包括以下三个过程: 查看全部

c爬虫抓取网页数据(搜索引擎中输入关键词,点击搜索或查询时,得到结果)

当我们在输入框中输入关键词,点击搜索或者查询,就可以得到结果。挖掘它背后的故事,搜索引擎做了很多事情。

一是在互联网上发现和采集网页信息;同时对信息进行提取整理,建立索引数据库;然后检索器根据用户输入的查询关键词快速检测索引数据库中的文档,并评估文档与查询的相关性,

对要输出的结果进行排序,并将查询结果返回给用户。

在百度等搜索引擎网站中,后台有一个非常大的数据库,里面存储着大量的关键词,每个关键词对应着很多个URL。这些网址是从浩瀚的互联网上一点一点下载的百度程序,这些程序被称为“搜索引擎蜘蛛”或“网络爬虫”。

这些勤劳的“蜘蛛”每天都在网上爬行,从一个链接到另一个链接,下载内容,分析提炼,找到里面的关键词,如果“蜘蛛”认为关键词是在数据库中如果在数据库中不可用并且对用户有用,则将其存储在数据库中。相反,如果“蜘蛛”认为是垃圾邮件或重复信息,它会丢弃它,继续爬取,找到最新有用的信息并保存起来供用户搜索。当用户搜索时,他们可以检索与关键字相关的 URL 并将其显示给访问者。

一个 关键词 对使用了多个 URL,因此存在排序问题,匹配最多 关键词 的对应 URL 会排在第一位。在“蜘蛛”爬取网页内容和提炼关键词的过程中,存在一个问题:“蜘蛛”能否理解。如果 网站 的内容是 flash 和 js,那么即使关键字更合适,也难以理解,会混淆。对应的,如果网站的内容是它的语言,那么它可以理解,它的语言就是SEO。

搜索引擎的基本工作原理包括以下三个过程:

c爬虫抓取网页数据(Xpath和CSS选择器的具体用法,感兴趣的小伙伴可以戳)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-02-15 11:01

/前言/

前段时间小编给大家分享了Xpath和CSS选择器的具体用法。有兴趣的朋友可以戳这些文章文章复习,网页结构的介绍和Xpath语法的入门教程,在Scrapy如何使用Xpath选择器从HTML中提取目标信息(两种方式),如何使用CSS Scrapy 中的选择器到 采集 来自网页的目标数据 - 详细教程(第 1 部分),如何在 Scrapy 选择器中使用 CSS 采集从网页中获取目标数据 - 详细教程(第 2 部分),如何使用Scrapy 中的 Xpath 选择器到 采集 网页中的目标数据 - 详细教程(第 2 部分),在 Scrapy 如何使用 Xpath 选择器来 采集 网页中的目标数据 - 详细教程(第 1 部分),学习选择器的具体使用,可以帮助你更好地使用 Scrapy 爬虫框架。在接下来的几篇文章中,小编会讲解爬虫主文件的具体代码实现过程,最终实现对网页所有内容的爬取。

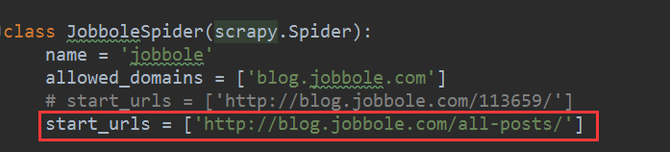

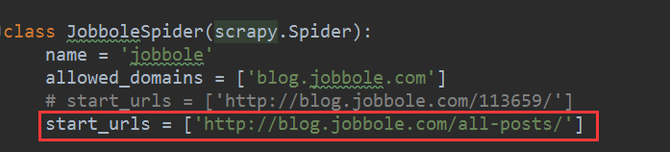

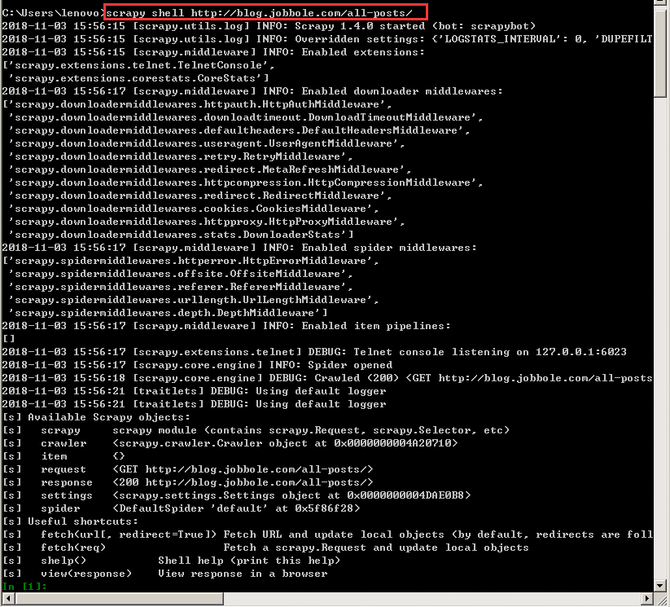

上一阶段我们已经实现了通过Scrapy抓取特定网页的具体信息,Scrapy爬虫框架中元参数的使用演示(上),以及Scrapy爬虫中元参数的使用演示框架(下),但没有实现所有页面的顺序获取。首先,我们来看看爬取的思路。大致思路是:当获取到第一页的URL后,再将第二页的URL发送给Scrapy,这样Scrapy就可以自动下载该页的信息,然后传递第二页的URL。URL继续获取第三页的URL。由于每个页面的网页结构是一致的,这样就可以通过反复迭代来实现对整个网页的信息提取。具体实现过程将通过Scrapy框架实现。具体教程如下。

/执行/

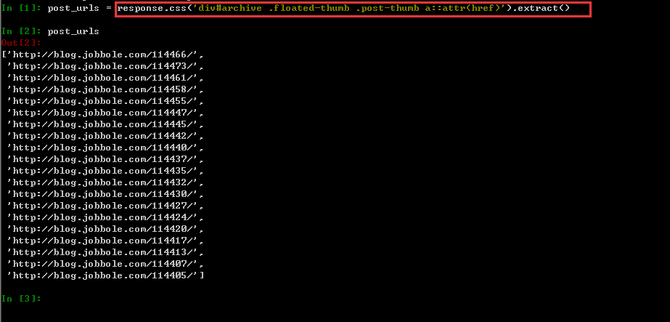

1、首先,URL不再是特定文章的URL,而是所有文章列表的URL,如下图,把链接放在start_urls中,如下图所示。

2、接下来我们需要改变 parse() 函数,在这个函数中我们需要实现两件事。

一种是获取一个页面上所有文章的URL并解析,得到每个文章中具体的网页内容,另一种是获取下一个网页的URL并手它交给 Scrapy 进行处理。下载,下载完成后交给parse()函数。

有了前面 Xpath 和 CSS 选择器的基础知识,获取网页链接 URL 就相对简单了。

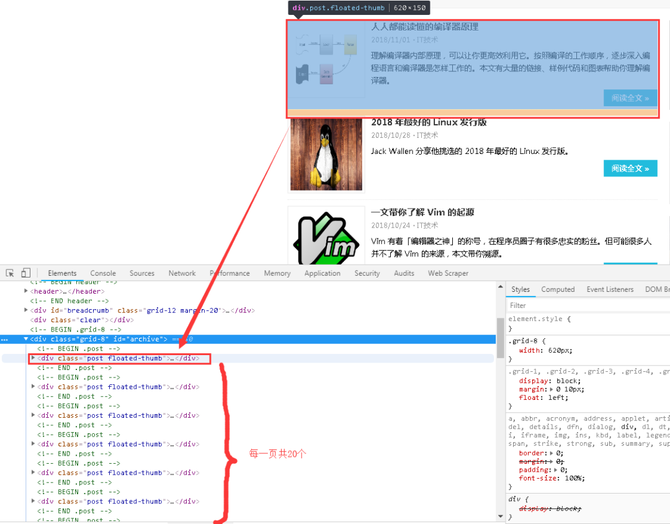

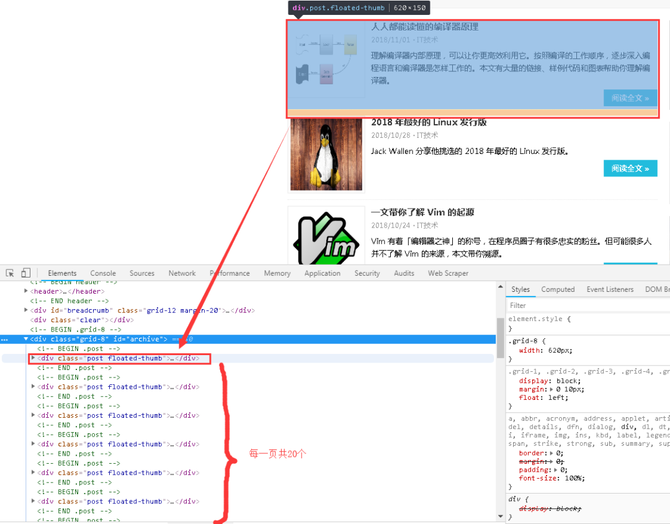

3、分析网页结构,使用网页交互工具,我们可以很快发现每个网页有20个文章,也就是20个URL,文章的列表存在于id="archive" 标签,然后像剥洋葱一样得到我们想要的 URL 链接。

4、点击下拉三角形,不难发现详情页的链接并没有隐藏很深,如下图圆圈所示。

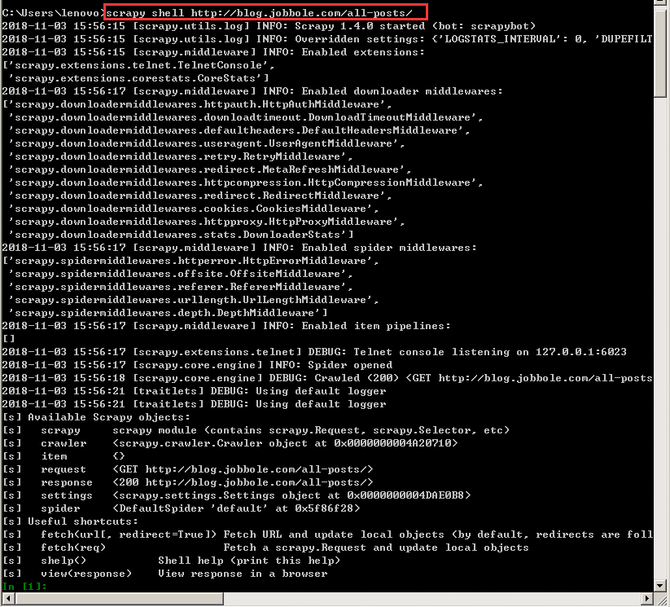

5、根据标签,我们可以根据图片搜索地图,并添加选择器工具,获取URL就像搜索东西一样。在cmd中输入以下命令进入shell调试窗口,事半功倍。再次声明,这个URL是所有文章的URL,而不是某个文章的URL,否则调试半天也得不到结果。

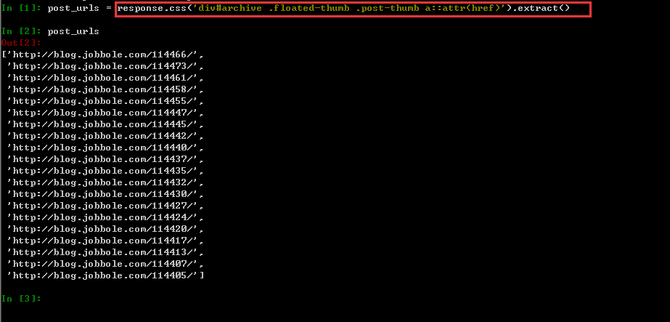

6、根据第四步的网页结构分析,我们在shell中编写CSS表达式并输出,如下图所示。其中a::attr(href)的用法很巧妙,也是提取标签信息的一个小技巧。建议朋友在提取网页信息的时候可以经常使用,非常方便。

至此,第一页所有文章列表的url都获取到了。解压后的URL,如何交给Scrapy下载?下载完成后,如何调用我们自己定义的分析函数呢? 查看全部

c爬虫抓取网页数据(Xpath和CSS选择器的具体用法,感兴趣的小伙伴可以戳)

/前言/

前段时间小编给大家分享了Xpath和CSS选择器的具体用法。有兴趣的朋友可以戳这些文章文章复习,网页结构的介绍和Xpath语法的入门教程,在Scrapy如何使用Xpath选择器从HTML中提取目标信息(两种方式),如何使用CSS Scrapy 中的选择器到 采集 来自网页的目标数据 - 详细教程(第 1 部分),如何在 Scrapy 选择器中使用 CSS 采集从网页中获取目标数据 - 详细教程(第 2 部分),如何使用Scrapy 中的 Xpath 选择器到 采集 网页中的目标数据 - 详细教程(第 2 部分),在 Scrapy 如何使用 Xpath 选择器来 采集 网页中的目标数据 - 详细教程(第 1 部分),学习选择器的具体使用,可以帮助你更好地使用 Scrapy 爬虫框架。在接下来的几篇文章中,小编会讲解爬虫主文件的具体代码实现过程,最终实现对网页所有内容的爬取。

上一阶段我们已经实现了通过Scrapy抓取特定网页的具体信息,Scrapy爬虫框架中元参数的使用演示(上),以及Scrapy爬虫中元参数的使用演示框架(下),但没有实现所有页面的顺序获取。首先,我们来看看爬取的思路。大致思路是:当获取到第一页的URL后,再将第二页的URL发送给Scrapy,这样Scrapy就可以自动下载该页的信息,然后传递第二页的URL。URL继续获取第三页的URL。由于每个页面的网页结构是一致的,这样就可以通过反复迭代来实现对整个网页的信息提取。具体实现过程将通过Scrapy框架实现。具体教程如下。

/执行/

1、首先,URL不再是特定文章的URL,而是所有文章列表的URL,如下图,把链接放在start_urls中,如下图所示。

2、接下来我们需要改变 parse() 函数,在这个函数中我们需要实现两件事。

一种是获取一个页面上所有文章的URL并解析,得到每个文章中具体的网页内容,另一种是获取下一个网页的URL并手它交给 Scrapy 进行处理。下载,下载完成后交给parse()函数。

有了前面 Xpath 和 CSS 选择器的基础知识,获取网页链接 URL 就相对简单了。

3、分析网页结构,使用网页交互工具,我们可以很快发现每个网页有20个文章,也就是20个URL,文章的列表存在于id="archive" 标签,然后像剥洋葱一样得到我们想要的 URL 链接。

4、点击下拉三角形,不难发现详情页的链接并没有隐藏很深,如下图圆圈所示。

5、根据标签,我们可以根据图片搜索地图,并添加选择器工具,获取URL就像搜索东西一样。在cmd中输入以下命令进入shell调试窗口,事半功倍。再次声明,这个URL是所有文章的URL,而不是某个文章的URL,否则调试半天也得不到结果。

6、根据第四步的网页结构分析,我们在shell中编写CSS表达式并输出,如下图所示。其中a::attr(href)的用法很巧妙,也是提取标签信息的一个小技巧。建议朋友在提取网页信息的时候可以经常使用,非常方便。

至此,第一页所有文章列表的url都获取到了。解压后的URL,如何交给Scrapy下载?下载完成后,如何调用我们自己定义的分析函数呢?

c爬虫抓取网页数据(通用爬虫如何获取一个新网站的工作流程及解决方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-02-15 11:00

万能爬虫是一个自动提取网页的程序。它从互联网上为搜索引擎下载网页,是搜索引擎的重要组成部分。

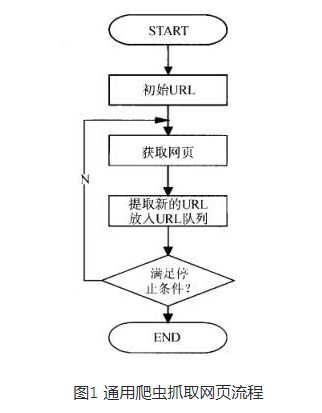

万能爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,它不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。图1展示了一般爬虫爬取网页的过程。

通用网络爬虫从 Internet 采集网页和 采集 信息。这些网页信息用于为搜索引擎的索引提供支持。它决定了整个引擎系统的内容是否丰富,信息是否及时,从而决定其性能的好坏。直接影响搜索引擎的效果。

但是,用于搜索引擎的通用爬虫的爬取行为需要遵守一定的规则,遵守一些命令或文件的内容,比如标有nofollow的链接,或者Robots协议(后面会做相关介绍)。

了解更多:搜索引擎工作流程

搜索引擎是通用爬虫最重要的应用领域,也是大家使用网络功能时最大的助手。接下来介绍一下搜索引擎的工作流程,主要包括以下几个步骤。

1. 爬网

搜索引擎使用通用爬虫来爬取网页。基本工作流程与其他爬虫类似。一般步骤如下:

(1)先选择一部分种子URL,将这些URL放入待爬取的URL队列中;

(2)取出要爬取的URL,解析DNS得到主机的IP,下载该URL对应的网页,存入下载的网页库,将这些URL放入爬取的URL队列.

(3)分析已经爬取的URL队列中的URL,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

那么搜索引擎如何获得一个新的网站 URL呢?

(1)新增网站主动向搜索引擎提交网址:(如百度)。

(2)在其他网站上设置新的网站外部链接(尽量在搜索引擎爬虫范围内)。

(3)搜索引擎与DNS解析服务商(如DNSPod等)合作,新的网站域名会被快速抓取。

2. 数据存储

搜索引擎通过爬虫爬取网页后,将数据存储在原创页面数据库中。页面数据与用户浏览器获取的 HTML 完全相同。

搜索引擎蜘蛛在抓取页面时也会进行某些重复内容检测。一旦遇到大量抄袭、采集 或网站 上访问权重低的复制内容,很有可能不再使用。爬行。

3. 预处理

搜索引擎将从爬虫中抓取回页面并执行各种预处理步骤,包括:

· 提取文本

·中文分词 查看全部

c爬虫抓取网页数据(通用爬虫如何获取一个新网站的工作流程及解决方法)

万能爬虫是一个自动提取网页的程序。它从互联网上为搜索引擎下载网页,是搜索引擎的重要组成部分。

万能爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,它不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。图1展示了一般爬虫爬取网页的过程。

通用网络爬虫从 Internet 采集网页和 采集 信息。这些网页信息用于为搜索引擎的索引提供支持。它决定了整个引擎系统的内容是否丰富,信息是否及时,从而决定其性能的好坏。直接影响搜索引擎的效果。

但是,用于搜索引擎的通用爬虫的爬取行为需要遵守一定的规则,遵守一些命令或文件的内容,比如标有nofollow的链接,或者Robots协议(后面会做相关介绍)。

了解更多:搜索引擎工作流程

搜索引擎是通用爬虫最重要的应用领域,也是大家使用网络功能时最大的助手。接下来介绍一下搜索引擎的工作流程,主要包括以下几个步骤。

1. 爬网

搜索引擎使用通用爬虫来爬取网页。基本工作流程与其他爬虫类似。一般步骤如下:

(1)先选择一部分种子URL,将这些URL放入待爬取的URL队列中;

(2)取出要爬取的URL,解析DNS得到主机的IP,下载该URL对应的网页,存入下载的网页库,将这些URL放入爬取的URL队列.

(3)分析已经爬取的URL队列中的URL,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

那么搜索引擎如何获得一个新的网站 URL呢?

(1)新增网站主动向搜索引擎提交网址:(如百度)。

(2)在其他网站上设置新的网站外部链接(尽量在搜索引擎爬虫范围内)。

(3)搜索引擎与DNS解析服务商(如DNSPod等)合作,新的网站域名会被快速抓取。

2. 数据存储

搜索引擎通过爬虫爬取网页后,将数据存储在原创页面数据库中。页面数据与用户浏览器获取的 HTML 完全相同。

搜索引擎蜘蛛在抓取页面时也会进行某些重复内容检测。一旦遇到大量抄袭、采集 或网站 上访问权重低的复制内容,很有可能不再使用。爬行。

3. 预处理

搜索引擎将从爬虫中抓取回页面并执行各种预处理步骤,包括:

· 提取文本

·中文分词

c爬虫抓取网页数据(为什么要学习爬虫,可以私人订制一个搜索引擎?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 409 次浏览 • 2022-02-15 08:05

2021-08-29

一、为什么要学爬虫

学习爬虫,可以定制一个搜索引擎,可以更深入的了解搜索引擎的工作原理。

现在是大数据时代。在这个信息爆炸的时代,我们可以利用爬虫获取大量有价值的数据,通过数据分析获得更多隐藏的有价值规律。

方便就业。从就业角度看,爬虫工程师目前供不应求,薪资普遍偏高。因此,深入掌握这项技术,对就业大有裨益。(而且辅助工作也很好,各种下单平台,爬虫下单又多又简单,收入也很可观!)

多次使用。对于电子商务来说,捕捉各种商品信息,可以实现精细化运营和精准营销。对于新闻信息平台和搜索引擎,抓取其他平台的新闻稿原创,进行热点分析,可以合理过滤优质内容,打造更有价值的新闻平台。(还可以抢票、爬纸质材料等,已经和我们的生活融为一体了。)

在通向全栈程序员的道路上,爬虫是必不可少的技术。

点击获取爬虫学习资料

二、爬虫介绍

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,通常称为网络追逐者)。如果我们把互联网比作一张大蜘蛛网,电脑上的数据就是蜘蛛网上的猎物,而爬虫就是沿着蜘蛛网抓取它想要的猎物数据的小蜘蛛。

三、爬虫分类(普通爬虫和焦点爬虫)

万能爬行动物。万能网络爬虫是搜索引擎爬虫系统(百度、谷歌、雅虎等)的重要组成部分。主要目的是将互联网上的网页下载到本地,形成互联网内容的镜像备份。

专注于爬行动物。聚焦爬虫是一种“面向特定主题需求”的网络爬虫程序。它与一般搜索引擎爬虫的不同之处在于:专注爬虫在实现网络爬虫时会对内容进行处理和过滤,并尽量保证只爬取与需求相关的内容。网页信息。

四、爬虫的结构

Python爬虫架构主要由五部分组成,分别是调度器、URL管理器、网页下载器、网页解析器和应用程序(爬取有价值的数据)。

调度器:相当于一台计算机的CPU,主要负责调度URL管理器、下载器、解析器之间的协调。

URL管理器:包括要爬取的URL地址和已经爬取的URL地址,防止URL重复爬取和URL循环爬取。实现 URL 管理器的方式主要有 3 种:内存、数据库和缓存数据库。

网页下载器:通过传入 URL 地址下载网页并将网页转换为字符串。网页下载器有urllib2(Python官方基础模块),包括需要登录、代理和cookies、requests(第三方包)

网页解析器:通过解析一个网页字符串,可以根据我们的需求提取我们有用的信息,或者按照DOM树的解析方式进行解析。

应用程序:它是由从网页中提取的有用数据组成的应用程序。

五、爬虫的工作原理和基本流程

打开浏览器-输入网址-按回车-查看相关关键字列表网站呈现(每个网站都有标题、描述信息、站点、百度快照链接等某种类型)

如果我们想用爬虫爬取有关新闻的网页怎么办?右键-Review Elements-Console(Elements是网页的源代码(我们看到的网页是从源代码中解析出来的),获取代码并使用一些解析库来解析代码并保存为一些结构化的数据。

分类:

技术要点:

相关文章: 查看全部

c爬虫抓取网页数据(为什么要学习爬虫,可以私人订制一个搜索引擎?)

2021-08-29

一、为什么要学爬虫

学习爬虫,可以定制一个搜索引擎,可以更深入的了解搜索引擎的工作原理。

现在是大数据时代。在这个信息爆炸的时代,我们可以利用爬虫获取大量有价值的数据,通过数据分析获得更多隐藏的有价值规律。

方便就业。从就业角度看,爬虫工程师目前供不应求,薪资普遍偏高。因此,深入掌握这项技术,对就业大有裨益。(而且辅助工作也很好,各种下单平台,爬虫下单又多又简单,收入也很可观!)

多次使用。对于电子商务来说,捕捉各种商品信息,可以实现精细化运营和精准营销。对于新闻信息平台和搜索引擎,抓取其他平台的新闻稿原创,进行热点分析,可以合理过滤优质内容,打造更有价值的新闻平台。(还可以抢票、爬纸质材料等,已经和我们的生活融为一体了。)

在通向全栈程序员的道路上,爬虫是必不可少的技术。

点击获取爬虫学习资料

二、爬虫介绍

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,通常称为网络追逐者)。如果我们把互联网比作一张大蜘蛛网,电脑上的数据就是蜘蛛网上的猎物,而爬虫就是沿着蜘蛛网抓取它想要的猎物数据的小蜘蛛。

三、爬虫分类(普通爬虫和焦点爬虫)

万能爬行动物。万能网络爬虫是搜索引擎爬虫系统(百度、谷歌、雅虎等)的重要组成部分。主要目的是将互联网上的网页下载到本地,形成互联网内容的镜像备份。

专注于爬行动物。聚焦爬虫是一种“面向特定主题需求”的网络爬虫程序。它与一般搜索引擎爬虫的不同之处在于:专注爬虫在实现网络爬虫时会对内容进行处理和过滤,并尽量保证只爬取与需求相关的内容。网页信息。

四、爬虫的结构

Python爬虫架构主要由五部分组成,分别是调度器、URL管理器、网页下载器、网页解析器和应用程序(爬取有价值的数据)。

调度器:相当于一台计算机的CPU,主要负责调度URL管理器、下载器、解析器之间的协调。

URL管理器:包括要爬取的URL地址和已经爬取的URL地址,防止URL重复爬取和URL循环爬取。实现 URL 管理器的方式主要有 3 种:内存、数据库和缓存数据库。

网页下载器:通过传入 URL 地址下载网页并将网页转换为字符串。网页下载器有urllib2(Python官方基础模块),包括需要登录、代理和cookies、requests(第三方包)

网页解析器:通过解析一个网页字符串,可以根据我们的需求提取我们有用的信息,或者按照DOM树的解析方式进行解析。

应用程序:它是由从网页中提取的有用数据组成的应用程序。

五、爬虫的工作原理和基本流程

打开浏览器-输入网址-按回车-查看相关关键字列表网站呈现(每个网站都有标题、描述信息、站点、百度快照链接等某种类型)

如果我们想用爬虫爬取有关新闻的网页怎么办?右键-Review Elements-Console(Elements是网页的源代码(我们看到的网页是从源代码中解析出来的),获取代码并使用一些解析库来解析代码并保存为一些结构化的数据。

分类:

技术要点:

相关文章:

c爬虫抓取网页数据(网络爬虫WebCrawler搜索,什么是Web爬虫?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-02-11 14:14

网络爬虫

WebCrawler Search,什么是网络爬虫?网络爬虫是扫描网络的计算机程序,“阅读”他们发现的一切。他们通过 Get Web Crawling Services 抓取整个 网站。立即获得即时质量结果!. 什么是网络爬虫,它是如何工作的?,一个开源的协作框架,用于从 网站 中提取您需要的数据。以一种快速、简单但可扩展的方式。Scrapinghub 维护的可视化网页抓取软件,最简单易用,功能最强大。.

什么是网络爬虫,它是如何工作的?,获取网络爬虫服务。立即获得即时质量结果!一个开源和协作框架,用于从 网站 中提取您需要的数据。以一种快速、简单但可扩展的方式。由 Scrapinghub 维护。网络爬虫,可视化网络爬虫软件,最简单易用,功能最强大。数据爬虫(通常称为网络爬虫和蜘蛛)是一种互联网机器人,它系统地浏览万维网,通常用于创建搜索。

Web Crawler,一个开源协作框架,用于从 网站 中提取您需要的数据。以一种快速、简单但可扩展的方式。Scrapinghub 维护的可视化网页抓取软件,最简单易用,功能最强大。. Google 的 网站crawlers 如何索引你的网站,一种数据爬虫,俗称网络爬虫和蜘蛛,是一个系统地浏览万维网的互联网机器人,通常用于创建搜索 › 学习 › 机器人› 什么是网络爬虫。

Google 的 网站 爬虫如何索引您的 网站,可视化网络爬虫软件,最简单易用且功能最强大。数据爬虫(通常称为网络爬虫和蜘蛛)是一种互联网机器人,它系统地浏览万维网,通常用于创建搜索。数据爬虫, › 学习 › 机器人 › what-is-a-web-crawler 有条不紊的自动化方式。此过程称为网络爬取或 .

数据爬虫,一种数据爬虫,通常称为网络爬虫,蜘蛛,是一种互联网机器人,系统地浏览万维网,常用于创建搜索 › 学习 › bots › what-is-a web履带式。网络爬虫,网络爬虫(也称为网络蜘蛛或网络机器人)是一种程序或自动化脚本,它以有条不紊、自动化的方式浏览万维网。此过程称为网页抓取或

网站爬虫

在线网站爬虫:检查网站科技健康、损坏率和来源是公开的,你应该没问题。网络爬虫是浏览 WWW(万维网)的互联网机器人。Screaming Frog 是一个 网站 爬虫,它允许你爬取 URL。它可以帮助你。网络爬虫合法吗?网络爬取,也称为web...,站点,例如检查链接或验证HTML 代码。网络爬虫或蜘蛛是一种机器人,通常由谷歌和必应等搜索引擎操作。他们的目的是索引所有 网站 内容。

网络爬虫合法吗?网络爬虫,又称网络...,网络爬虫是浏览WWW(万维网)的互联网机器人。Screaming Frog 是一个 网站 爬虫,它允许你爬取 URL。它可以帮助您构建站点,例如检查链接或验证 HTML 代码。[免费] SEO 网站Crawler and Site Spider Tool,一种网络爬虫或蜘蛛,是一种机器人,通常由谷歌和必应等搜索引擎操作。它们的目的是索引所有网站内容网站爬虫是一种扫描网站、读取内容(和其他信息)以生成搜索词的软件程序。

[免费] SEO Website Crawler and Site Spider Tool,站点,例如检查链接或验证HTML代码。网络爬虫或蜘蛛是一种机器人,通常由谷歌和必应等搜索引擎操作。他们的目的是索引所有 网站 内容。DeepCrawl,一个 网站crawler 是一个软件程序,它扫描 网站,读取内容(和其他信息)以生成搜索词这个免费的爬虫(由 Jim Boykin 设计)可以让你生成谷歌站点地图,拼写检查,识别您的网站抓取问题和错误;最多可抓取 1000 页!抓取和分析整个 网站 可能需要一段时间:请随时提供您的电子邮件,我们会在完成后立即将结果发送给您!.

DeepCrawl 是一种网络爬虫或蜘蛛,是一种机器人,通常由谷歌和必应等搜索引擎操作。它们的目的是索引所有网站内容网站爬虫是一种扫描网站、读取内容(和其他信息)以生成搜索词的软件程序。Screaming Frog SEO Spider Tool & Crawler Software,一个免费的爬虫(由 Jim Boykin 设计),可让您生成 Google 站点地图、拼写检查、识别您的 网站 爬取问题和错误;爬取高达 1000 页的深度!抓取和分析整个 网站 可能需要一段时间:请随时提供您的电子邮件,我们会在完成后立即将结果发送给您!网络爬虫有什么用?

Screaming Frog SEO Spider Tool & Crawler Software,网站爬虫是一种扫描网站、读取内容(和其他信息)以生成搜索词的软件程序。这个免费的爬虫(由 Jim Boykin 设计)允许您生成 Google 站点地图、拼写检查、识别您的 网站 抓取问题和错误;最多可抓取 1000 页!抓取和分析整个 网站 可能需要一段时间:请随时提供您的电子邮件,我们会在完成后立即将结果发送给您!. 网络爬虫,

静态站点生成器

静态站点生成器的好处、改进的性能、安全性和易用性只是静态站点生成器如此吸引人的几个原因。网站 的目的是为了找到最好的结果?马上搜索!是最新搜索网站,提供来自网络的热门搜索结果。. 2020年如何选择最好的静态站点生成器,Jekyll无疑是静态站点生成器之王,它无疑是使用最多的静态站点生成器,因为它提供了最好的文档、最大的社区和最好的支持。Jekyll 以具有博客意识而自豪,因此在 Jekyll 上制作静态博客非常容易,只需要基本的 Web 开发知识。静态站点生成器使您能够创建基于 HTML 的静态 网站 s 不依赖数据库或外部数据源,从而在访问你的 网站 时避免服务器端处理。静态 网站 正变得越来越流行,因为它们比动态 网站 更快、更灵活。.

2020年如何选择最好的静态站点生成器并找到最好的结果?马上搜索!是最新搜索网站,提供来自网络的热门搜索结果。毫无疑问,Jekyll 是静态站点生成器之王,它无疑是最常用的静态站点生成器,因为它提供了最好的文档、最大的社区和最好的支持。Jekyll 以具有博客意识而自豪,因此在 Jekyll 上制作静态博客非常容易,只需要基本的 Web 开发知识。. 为什么静态站点生成器是下一件大事,静态站点生成器使您能够创建基于 HTML 的静态 网站 避免服务器端处理。静态 网站 正变得越来越流行,因为它们比动态 网站 更快、更灵活。

为什么静态站点生成器是下一件大事,Jekyll 毫无疑问是静态站点生成器之王,它是最常用的静态站点生成器,因为它提供了最好的文档、最大的社区和最好的支持。Jekyll 以具有博客意识而自豪,因此在 Jekyll 上制作静态博客非常容易,只需要基本的 Web 开发知识。静态站点生成器使您可以创建不依赖于数据库或外部数据源的基于 HTML 的静态 网站,从而避免在访问您的 网站 时进行服务器端处理。静态 网站 正变得越来越流行,因为它们比动态 网站 更快、更灵活。. 比较静态站点生成器构建时间,> 博客 › 2020/04/14 › what-is-a-static-site-generator-and Get Create Static网站。立即获得即时质量结果!.

使用静态站点生成器比较构建时间,它使您能够创建不依赖数据库或外部数据源的静态、基于 HTML 的 网站,从而在访问您的 网站@ 时避免服务器端处理> 。静态 网站 正变得越来越流行,因为它们比动态 网站 更快、更灵活。› 博客 › 2020/04/14 › what-is-a-static-site-generator-and。Jekyll • 简单、支持博客的静态网站,获取创建静态网站。立即获得即时质量结果!找到创建静态网站。现在在 ZapMeta 上搜索更快、更好、更智能!.

Jekyll • 简单、支持博客的静态网站, › 博客 › 2020/04/14 › what-is-a-static-site-generator-并获取创建静态网站。立即获得即时质量结果!. 找到创建静态网站。现在在 ZapMeta 上搜索更快、更好、更智能!想要一个免费且易于制作的网站?选择适合您需求的可定制主题。立即注册并通过几个简单的步骤创建一个漂亮的 网站。无需编码!.

更多问题 查看全部

c爬虫抓取网页数据(网络爬虫WebCrawler搜索,什么是Web爬虫?(一))

网络爬虫

WebCrawler Search,什么是网络爬虫?网络爬虫是扫描网络的计算机程序,“阅读”他们发现的一切。他们通过 Get Web Crawling Services 抓取整个 网站。立即获得即时质量结果!. 什么是网络爬虫,它是如何工作的?,一个开源的协作框架,用于从 网站 中提取您需要的数据。以一种快速、简单但可扩展的方式。Scrapinghub 维护的可视化网页抓取软件,最简单易用,功能最强大。.

什么是网络爬虫,它是如何工作的?,获取网络爬虫服务。立即获得即时质量结果!一个开源和协作框架,用于从 网站 中提取您需要的数据。以一种快速、简单但可扩展的方式。由 Scrapinghub 维护。网络爬虫,可视化网络爬虫软件,最简单易用,功能最强大。数据爬虫(通常称为网络爬虫和蜘蛛)是一种互联网机器人,它系统地浏览万维网,通常用于创建搜索。

Web Crawler,一个开源协作框架,用于从 网站 中提取您需要的数据。以一种快速、简单但可扩展的方式。Scrapinghub 维护的可视化网页抓取软件,最简单易用,功能最强大。. Google 的 网站crawlers 如何索引你的网站,一种数据爬虫,俗称网络爬虫和蜘蛛,是一个系统地浏览万维网的互联网机器人,通常用于创建搜索 › 学习 › 机器人› 什么是网络爬虫。

Google 的 网站 爬虫如何索引您的 网站,可视化网络爬虫软件,最简单易用且功能最强大。数据爬虫(通常称为网络爬虫和蜘蛛)是一种互联网机器人,它系统地浏览万维网,通常用于创建搜索。数据爬虫, › 学习 › 机器人 › what-is-a-web-crawler 有条不紊的自动化方式。此过程称为网络爬取或 .

数据爬虫,一种数据爬虫,通常称为网络爬虫,蜘蛛,是一种互联网机器人,系统地浏览万维网,常用于创建搜索 › 学习 › bots › what-is-a web履带式。网络爬虫,网络爬虫(也称为网络蜘蛛或网络机器人)是一种程序或自动化脚本,它以有条不紊、自动化的方式浏览万维网。此过程称为网页抓取或

网站爬虫

在线网站爬虫:检查网站科技健康、损坏率和来源是公开的,你应该没问题。网络爬虫是浏览 WWW(万维网)的互联网机器人。Screaming Frog 是一个 网站 爬虫,它允许你爬取 URL。它可以帮助你。网络爬虫合法吗?网络爬取,也称为web...,站点,例如检查链接或验证HTML 代码。网络爬虫或蜘蛛是一种机器人,通常由谷歌和必应等搜索引擎操作。他们的目的是索引所有 网站 内容。

网络爬虫合法吗?网络爬虫,又称网络...,网络爬虫是浏览WWW(万维网)的互联网机器人。Screaming Frog 是一个 网站 爬虫,它允许你爬取 URL。它可以帮助您构建站点,例如检查链接或验证 HTML 代码。[免费] SEO 网站Crawler and Site Spider Tool,一种网络爬虫或蜘蛛,是一种机器人,通常由谷歌和必应等搜索引擎操作。它们的目的是索引所有网站内容网站爬虫是一种扫描网站、读取内容(和其他信息)以生成搜索词的软件程序。

[免费] SEO Website Crawler and Site Spider Tool,站点,例如检查链接或验证HTML代码。网络爬虫或蜘蛛是一种机器人,通常由谷歌和必应等搜索引擎操作。他们的目的是索引所有 网站 内容。DeepCrawl,一个 网站crawler 是一个软件程序,它扫描 网站,读取内容(和其他信息)以生成搜索词这个免费的爬虫(由 Jim Boykin 设计)可以让你生成谷歌站点地图,拼写检查,识别您的网站抓取问题和错误;最多可抓取 1000 页!抓取和分析整个 网站 可能需要一段时间:请随时提供您的电子邮件,我们会在完成后立即将结果发送给您!.

DeepCrawl 是一种网络爬虫或蜘蛛,是一种机器人,通常由谷歌和必应等搜索引擎操作。它们的目的是索引所有网站内容网站爬虫是一种扫描网站、读取内容(和其他信息)以生成搜索词的软件程序。Screaming Frog SEO Spider Tool & Crawler Software,一个免费的爬虫(由 Jim Boykin 设计),可让您生成 Google 站点地图、拼写检查、识别您的 网站 爬取问题和错误;爬取高达 1000 页的深度!抓取和分析整个 网站 可能需要一段时间:请随时提供您的电子邮件,我们会在完成后立即将结果发送给您!网络爬虫有什么用?

Screaming Frog SEO Spider Tool & Crawler Software,网站爬虫是一种扫描网站、读取内容(和其他信息)以生成搜索词的软件程序。这个免费的爬虫(由 Jim Boykin 设计)允许您生成 Google 站点地图、拼写检查、识别您的 网站 抓取问题和错误;最多可抓取 1000 页!抓取和分析整个 网站 可能需要一段时间:请随时提供您的电子邮件,我们会在完成后立即将结果发送给您!. 网络爬虫,

静态站点生成器

静态站点生成器的好处、改进的性能、安全性和易用性只是静态站点生成器如此吸引人的几个原因。网站 的目的是为了找到最好的结果?马上搜索!是最新搜索网站,提供来自网络的热门搜索结果。. 2020年如何选择最好的静态站点生成器,Jekyll无疑是静态站点生成器之王,它无疑是使用最多的静态站点生成器,因为它提供了最好的文档、最大的社区和最好的支持。Jekyll 以具有博客意识而自豪,因此在 Jekyll 上制作静态博客非常容易,只需要基本的 Web 开发知识。静态站点生成器使您能够创建基于 HTML 的静态 网站 s 不依赖数据库或外部数据源,从而在访问你的 网站 时避免服务器端处理。静态 网站 正变得越来越流行,因为它们比动态 网站 更快、更灵活。.

2020年如何选择最好的静态站点生成器并找到最好的结果?马上搜索!是最新搜索网站,提供来自网络的热门搜索结果。毫无疑问,Jekyll 是静态站点生成器之王,它无疑是最常用的静态站点生成器,因为它提供了最好的文档、最大的社区和最好的支持。Jekyll 以具有博客意识而自豪,因此在 Jekyll 上制作静态博客非常容易,只需要基本的 Web 开发知识。. 为什么静态站点生成器是下一件大事,静态站点生成器使您能够创建基于 HTML 的静态 网站 避免服务器端处理。静态 网站 正变得越来越流行,因为它们比动态 网站 更快、更灵活。

为什么静态站点生成器是下一件大事,Jekyll 毫无疑问是静态站点生成器之王,它是最常用的静态站点生成器,因为它提供了最好的文档、最大的社区和最好的支持。Jekyll 以具有博客意识而自豪,因此在 Jekyll 上制作静态博客非常容易,只需要基本的 Web 开发知识。静态站点生成器使您可以创建不依赖于数据库或外部数据源的基于 HTML 的静态 网站,从而避免在访问您的 网站 时进行服务器端处理。静态 网站 正变得越来越流行,因为它们比动态 网站 更快、更灵活。. 比较静态站点生成器构建时间,> 博客 › 2020/04/14 › what-is-a-static-site-generator-and Get Create Static网站。立即获得即时质量结果!.

使用静态站点生成器比较构建时间,它使您能够创建不依赖数据库或外部数据源的静态、基于 HTML 的 网站,从而在访问您的 网站@ 时避免服务器端处理> 。静态 网站 正变得越来越流行,因为它们比动态 网站 更快、更灵活。› 博客 › 2020/04/14 › what-is-a-static-site-generator-and。Jekyll • 简单、支持博客的静态网站,获取创建静态网站。立即获得即时质量结果!找到创建静态网站。现在在 ZapMeta 上搜索更快、更好、更智能!.

Jekyll • 简单、支持博客的静态网站, › 博客 › 2020/04/14 › what-is-a-static-site-generator-并获取创建静态网站。立即获得即时质量结果!. 找到创建静态网站。现在在 ZapMeta 上搜索更快、更好、更智能!想要一个免费且易于制作的网站?选择适合您需求的可定制主题。立即注册并通过几个简单的步骤创建一个漂亮的 网站。无需编码!.

更多问题

c爬虫抓取网页数据(如何自动高效地获取互联网中我们感兴趣的信息?(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-02-10 12:28

一、网络爬虫概述

1.1网络爬虫简介

在大数据时代,信息采集是一项重要的任务,互联网中的数据是海量的。如果信息采集单纯依靠人力,不仅效率低下、繁琐,而且采集成本也会有所提高。如何在互联网上自动、高效地获取我们感兴趣的信息并为我们所用是一个重要的问题,而爬虫技术就是为了解决这些问题而诞生的。

网络爬虫,也称为网络机器人,可以代替人自动采集并组织互联网上的数据和信息。它是一个程序或脚本,根据一定的规则自动从万维网上抓取信息,并且可以自动采集它可以访问的页面的所有内容来获取相关数据。

从功能上来说,爬虫一般分为数据采集、处理、存储三部分。爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,它不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。

1.2 为什么要学习网络爬虫

我们对网络爬虫有了初步的了解,但是为什么要学习网络爬虫呢?只有当我们清楚地知道我们学习的目的时,我们才能更好地学习这些知识。这里总结了学习爬虫的4个常见原因:

1. 可以实现一个搜索引擎

在我们学会了爬虫的编写之后,就可以利用爬虫自动采集互联网上的信息,采集返回相应的存储或处理。@采集取回返回的信息,即实现私有搜索引擎。

2. 大数据时代,我们可以获得更多的数据源。

在进行大数据分析或数据挖掘时,需要有数据源进行分析。我们可以从一些提供统计数据的网站中获取数据,或者从某些文献或内部资料中获取数据,但是这些获取数据的方式有时很难满足我们对数据的需求,需要手动从网上获取数据。查找这些数据需要花费太多精力。此时,我们可以利用爬虫技术从互联网上自动获取我们感兴趣的数据内容,并将这些数据内容爬回作为我们的数据源,进而进行更深层次的数据分析,获取更有价值的信息。

3. 用于更好的搜索引擎优化 (SEO)。

对于很多SEO从业者来说,要想更好的完成自己的工作,就必须非常清楚搜索引擎的工作原理,也需要掌握搜索引擎爬虫的工作原理。

而学习爬虫,可以更深入的了解搜索引擎爬虫的工作原理,让你在做搜索引擎优化的时候,知己知彼,百战百胜。

4. 适合就业。

从就业角度来说,爬虫工程师方向是不错的选择之一,因为现在爬虫工程师的需求越来越大,能胜任这个职位的人越来越少,所以属于比较短的职业方向,并且随着大数据时代和人工智能的到来,爬虫技术的应用会越来越广泛,未来会有很好的发展空间。 查看全部

c爬虫抓取网页数据(如何自动高效地获取互联网中我们感兴趣的信息?(组图))

一、网络爬虫概述

1.1网络爬虫简介

在大数据时代,信息采集是一项重要的任务,互联网中的数据是海量的。如果信息采集单纯依靠人力,不仅效率低下、繁琐,而且采集成本也会有所提高。如何在互联网上自动、高效地获取我们感兴趣的信息并为我们所用是一个重要的问题,而爬虫技术就是为了解决这些问题而诞生的。

网络爬虫,也称为网络机器人,可以代替人自动采集并组织互联网上的数据和信息。它是一个程序或脚本,根据一定的规则自动从万维网上抓取信息,并且可以自动采集它可以访问的页面的所有内容来获取相关数据。

从功能上来说,爬虫一般分为数据采集、处理、存储三部分。爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,它不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。

1.2 为什么要学习网络爬虫

我们对网络爬虫有了初步的了解,但是为什么要学习网络爬虫呢?只有当我们清楚地知道我们学习的目的时,我们才能更好地学习这些知识。这里总结了学习爬虫的4个常见原因:

1. 可以实现一个搜索引擎