网页源代码抓取工具

网页源代码抓取工具(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 30 次浏览 • 2021-12-14 19:20

捕获网页源代码的三种实现方法

更新时间:2013年6月5日11:14:45投稿:尚科

抓取网页源代码的三种实现方法,需要的朋友可以参考

方法1比较和建议

///

/// 用HttpWebRequest取得网页源码

/// 对于带BOM的网页很有效,不管是什么编码都能正确识别

///

/// 网页地址"

/// 返回网页源文件

public static string GetHtmlSource2(string url)

{

//处理内容

string html = "";

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.Accept = "*/*"; //接受任意文件

request.UserAgent = "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.1.4322)"; // 模拟使用IE在浏览 http://www.52mvc.com

request.AllowAutoRedirect = true;//是否允许302

//request.CookieContainer = new CookieContainer();//cookie容器,

request.Referer = url; //当前页面的引用

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, Encoding.Default);

html = reader.ReadToEnd();

stream.Close();

return html;

}

方法2

using System;

using System.Collections.Generic;

using System.Linq;

using System.Web;

using System.IO;

using System.Text;

using System.Net;

namespace MySql

{

public class GetHttpData

{

public static string GetHttpData2(string Url)

{

string sException = null;

string sRslt = null;

WebResponse oWebRps = null;

WebRequest oWebRqst = WebRequest.Create(Url);

oWebRqst.Timeout = 50000;

try

{

oWebRps = oWebRqst.GetResponse();

}

catch (WebException e)

{

sException = e.Message.ToString();

}

catch (Exception e)

{

sException = e.ToString();

}

finally

{

if (oWebRps != null)

{

StreamReader oStreamRd = new StreamReader(oWebRps.GetResponseStream(), Encoding.GetEncoding("utf-8"));

sRslt = oStreamRd.ReadToEnd();

oStreamRd.Close();

oWebRps.Close();

}

}

return sRslt;

}

}

}

方法3

<p>

public static string getHtml(string url, params string [] charSets)//url是要访问的网站地址,charSet是目标网页的编码,如果传入的是null或者"",那就自动分析网页的编码

{

try

{

string charSet = null;

if (charSets.Length == 1) {

charSet = charSets[0];

}

WebClient myWebClient = new WebClient(); //创建WebClient实例myWebClient

// 需要注意的:

//有的网页可能下不下来,有种种原因比如需要cookie,编码问题等等

//这是就要具体问题具体分析比如在头部加入cookie

// webclient.Headers.Add("Cookie", cookie);

//这样可能需要一些重载方法。根据需要写就可以了

//获取或设置用于对向 Internet 资源的请求进行身份验证的网络凭据。

myWebClient.Credentials = CredentialCache.DefaultCredentials;

//如果服务器要验证用户名,密码

//NetworkCredential mycred = new NetworkCredential(struser, strpassword);

//myWebClient.Credentials = mycred;

//从资源下载数据并返回字节数组。(加@是因为网址中间有"/"符号)

byte[] myDataBuffer = myWebClient.DownloadData(url);

string strWebData = Encoding.Default.GetString(myDataBuffer);

//获取网页字符编码描述信息

Match charSetMatch = Regex.Match(strWebData, " 查看全部

网页源代码抓取工具(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

捕获网页源代码的三种实现方法

更新时间:2013年6月5日11:14:45投稿:尚科

抓取网页源代码的三种实现方法,需要的朋友可以参考

方法1比较和建议

///

/// 用HttpWebRequest取得网页源码

/// 对于带BOM的网页很有效,不管是什么编码都能正确识别

///

/// 网页地址"

/// 返回网页源文件

public static string GetHtmlSource2(string url)

{

//处理内容

string html = "";

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.Accept = "*/*"; //接受任意文件

request.UserAgent = "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.1.4322)"; // 模拟使用IE在浏览 http://www.52mvc.com

request.AllowAutoRedirect = true;//是否允许302

//request.CookieContainer = new CookieContainer();//cookie容器,

request.Referer = url; //当前页面的引用

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, Encoding.Default);

html = reader.ReadToEnd();

stream.Close();

return html;

}

方法2

using System;

using System.Collections.Generic;

using System.Linq;

using System.Web;

using System.IO;

using System.Text;

using System.Net;

namespace MySql

{

public class GetHttpData

{

public static string GetHttpData2(string Url)

{

string sException = null;

string sRslt = null;

WebResponse oWebRps = null;

WebRequest oWebRqst = WebRequest.Create(Url);

oWebRqst.Timeout = 50000;

try

{

oWebRps = oWebRqst.GetResponse();

}

catch (WebException e)

{

sException = e.Message.ToString();

}

catch (Exception e)

{

sException = e.ToString();

}

finally

{

if (oWebRps != null)

{

StreamReader oStreamRd = new StreamReader(oWebRps.GetResponseStream(), Encoding.GetEncoding("utf-8"));

sRslt = oStreamRd.ReadToEnd();

oStreamRd.Close();

oWebRps.Close();

}

}

return sRslt;

}

}

}

方法3

<p>

public static string getHtml(string url, params string [] charSets)//url是要访问的网站地址,charSet是目标网页的编码,如果传入的是null或者"",那就自动分析网页的编码

{

try

{

string charSet = null;

if (charSets.Length == 1) {

charSet = charSets[0];

}

WebClient myWebClient = new WebClient(); //创建WebClient实例myWebClient

// 需要注意的:

//有的网页可能下不下来,有种种原因比如需要cookie,编码问题等等

//这是就要具体问题具体分析比如在头部加入cookie

// webclient.Headers.Add("Cookie", cookie);

//这样可能需要一些重载方法。根据需要写就可以了

//获取或设置用于对向 Internet 资源的请求进行身份验证的网络凭据。

myWebClient.Credentials = CredentialCache.DefaultCredentials;

//如果服务器要验证用户名,密码

//NetworkCredential mycred = new NetworkCredential(struser, strpassword);

//myWebClient.Credentials = mycred;

//从资源下载数据并返回字节数组。(加@是因为网址中间有"/"符号)

byte[] myDataBuffer = myWebClient.DownloadData(url);

string strWebData = Encoding.Default.GetString(myDataBuffer);

//获取网页字符编码描述信息

Match charSetMatch = Regex.Match(strWebData, "

网页源代码抓取工具(为了简单方便,这里使用WebBrowser来玩一把,我们要注意 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-12-14 11:11

)

为了简单方便,这里我们使用WebBrowser来玩,使用WebBrowser时要注意以下几点:

第一:因为WebBrowser是System.Windows.Forms中的winform控件,所以需要设置STAThread标签。

第二:Winform是事件驱动的,Console不响应事件,所有事件都在windows消息队列中等待执行,为了防止程序假死,

我们需要调用DoEvents方法来转移控制权,让操作系统执行其他事件。

第三:WebBrowser中的内容,我们需要使用DomDocument查看,而不是DocumentText。

当时考虑过直接通过XLINQ转换成XML,读取XML数据,但是觉得这样做风险很大。如果页面代码不规范,很容易转换成XML,会例外

所以考虑直接用一个整体来保存;

然后通过 htppHandler URL 重定向。好的

/要抓取数据的页面路径

string url = "https://www.sywebsoft.com/";

//将页面上的数据转换为HTML

string html = Method.GetHtmlData(url);

// txt_content.Text = html;

//找到需要的数据匹配正则 (?.+?)

string regex = @"(?.+?)";

Regex listRegex = new Regex(regex, RegexOptions.Multiline | RegexOptions.IgnoreCase);

//得到匹配的数据集合

MatchCollection mc = listRegex.Matches(html);

JCheng.Model.School Model = new JCheng.Model.School();

//将得到的字符串分割存进数组

string[] str = txt_content.Text.Substring(0, txt_content.Text.Length - 1).Replace("<br />", "").Split(,);

//数据每六个为一个model类 ,如下循环添加入库。

for (int i = 0; i < str.Length - 1; )

{

Model.sName = str[i];

Model.sAddress = str[i + 1];

Model.sPostCode = str[i + 2];

Model.sPhone = str[i + 3];

Model.sEmail = str[i + 4];

Model.sClass = str[i + 5];

new JCheng.BLL.School().Add(Model);

i += 6;

} 查看全部

网页源代码抓取工具(为了简单方便,这里使用WebBrowser来玩一把,我们要注意

)

为了简单方便,这里我们使用WebBrowser来玩,使用WebBrowser时要注意以下几点:

第一:因为WebBrowser是System.Windows.Forms中的winform控件,所以需要设置STAThread标签。

第二:Winform是事件驱动的,Console不响应事件,所有事件都在windows消息队列中等待执行,为了防止程序假死,

我们需要调用DoEvents方法来转移控制权,让操作系统执行其他事件。

第三:WebBrowser中的内容,我们需要使用DomDocument查看,而不是DocumentText。

当时考虑过直接通过XLINQ转换成XML,读取XML数据,但是觉得这样做风险很大。如果页面代码不规范,很容易转换成XML,会例外

所以考虑直接用一个整体来保存;

然后通过 htppHandler URL 重定向。好的

/要抓取数据的页面路径

string url = "https://www.sywebsoft.com/";

//将页面上的数据转换为HTML

string html = Method.GetHtmlData(url);

// txt_content.Text = html;

//找到需要的数据匹配正则 (?.+?)

string regex = @"(?.+?)";

Regex listRegex = new Regex(regex, RegexOptions.Multiline | RegexOptions.IgnoreCase);

//得到匹配的数据集合

MatchCollection mc = listRegex.Matches(html);

JCheng.Model.School Model = new JCheng.Model.School();

//将得到的字符串分割存进数组

string[] str = txt_content.Text.Substring(0, txt_content.Text.Length - 1).Replace("<br />", "").Split(,);

//数据每六个为一个model类 ,如下循环添加入库。

for (int i = 0; i < str.Length - 1; )

{

Model.sName = str[i];

Model.sAddress = str[i + 1];

Model.sPostCode = str[i + 2];

Model.sPhone = str[i + 3];

Model.sEmail = str[i + 4];

Model.sClass = str[i + 5];

new JCheng.BLL.School().Add(Model);

i += 6;

}

网页源代码抓取工具(网页源代码抓取工具,适合新手使用的软件!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2021-12-11 16:03

网页源代码抓取工具用来抓取网页时,最常用的工具莫过于爬虫软件,不仅能解析代码,抓取到网页内容,还能清晰地展示出来,以方便你后期的针对性分析。如果你用过be工具包的网页抓取,那这款网页抓取软件你一定用过,准确来说,它是如今最简单的网页抓取软件。方便快捷且功能强大,适合新手使用。

1、打开源代码抓取软件,

2、软件获取网页地址之后,

3、复制,提取网页内容,

4、高亮出关键词,点击识别关键词,

5、添加表单,

6、选择性获取内容如果你已经尝试过这款工具,建议你尽快使用,毕竟软件还是有很多地方可以提升功能的,希望你可以快乐地使用这款工具!下面这款工具是抓取自媒体平台的,设置更复杂一些:建议新手使用;没有用过以下工具也没有关系,等你通过实战学会了方法之后再回来这里看看,也许你会重新爱上这款工具!这款工具的名字叫干货传送门,对,就是那个不管干什么事,只要按照步骤做了,都会立马进入到目标页面!如果你没有这款工具的话,那就自己去搜索吧!那么点赞转发一下吧!你点赞了吗?!如果你觉得文章写得还不错,请你点个赞鼓励一下我!谢谢你们!如果你还有其他好工具,请在下方留言区留言,或者分享给你身边的人!谢谢你们!如果你想要实战学习抓取信息,可以从自媒体运营实战开始!大牛古今自媒体运营培训,15天让你成为一个自媒体运营高手,学会运营自媒体,成就自己的事业。 查看全部

网页源代码抓取工具(网页源代码抓取工具,适合新手使用的软件!)

网页源代码抓取工具用来抓取网页时,最常用的工具莫过于爬虫软件,不仅能解析代码,抓取到网页内容,还能清晰地展示出来,以方便你后期的针对性分析。如果你用过be工具包的网页抓取,那这款网页抓取软件你一定用过,准确来说,它是如今最简单的网页抓取软件。方便快捷且功能强大,适合新手使用。

1、打开源代码抓取软件,

2、软件获取网页地址之后,

3、复制,提取网页内容,

4、高亮出关键词,点击识别关键词,

5、添加表单,

6、选择性获取内容如果你已经尝试过这款工具,建议你尽快使用,毕竟软件还是有很多地方可以提升功能的,希望你可以快乐地使用这款工具!下面这款工具是抓取自媒体平台的,设置更复杂一些:建议新手使用;没有用过以下工具也没有关系,等你通过实战学会了方法之后再回来这里看看,也许你会重新爱上这款工具!这款工具的名字叫干货传送门,对,就是那个不管干什么事,只要按照步骤做了,都会立马进入到目标页面!如果你没有这款工具的话,那就自己去搜索吧!那么点赞转发一下吧!你点赞了吗?!如果你觉得文章写得还不错,请你点个赞鼓励一下我!谢谢你们!如果你还有其他好工具,请在下方留言区留言,或者分享给你身边的人!谢谢你们!如果你想要实战学习抓取信息,可以从自媒体运营实战开始!大牛古今自媒体运营培训,15天让你成为一个自媒体运营高手,学会运营自媒体,成就自己的事业。

网页源代码抓取工具(浏览器输入一个URL站点后看到网站页面内容(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-12-09 00:13

我们在浏览器中输入一个URL站点,按回车,就可以正常在浏览器中看到网站页面的内容了。其实这个过程就是浏览器向所在的服务器发送请求,告诉服务器请求什么。服务器收到请求后,对请求进行处理和解析。如果请求的处理和解析正常,则返回给浏览器。的回应。响应中收录页面的源代码等内容,浏览器解析响应中的源代码,最终显示解析出的网页。大致流程是:浏览器请求“服务器处理分析”服务器响应并传递给浏览器“浏览器分析渲染网页”。

让我们通过实际的网络站点来了解HTTP请求和响应的过程,以及在这个过程中发生了什么样的网络请求。以Chrome浏览器访问百度网站为例。

打开Chrome浏览器,在鼠标右键菜单中选择【检查】或直接快捷键【F12】打开开发者工具,切换到【网络】。在浏览器中输入百度站点:按回车键查看发生的网络请求。如下所示:

第一个网络请求:是浏览器向百度服务器发送的访问百度站点的请求。单击此请求可查看请求的详细信息和内容。

首先是General部分,描述了请求的URL、请求方法、响应状态码以及远程服务器的地址和端口;

下面有Response Headers和Request Headers,分别是响应头和请求头。收录响应和请求的部分相关信息和内容。我们来看看这个请求的具体内容和对应的响应。

请求的组成

请求由客户端即浏览器发送到服务器。发送的请求有4个方面:请求方法、请求URL、请求头、请求正文

1.请求方法

常见的请求有 get、post、put... 类型。get类型接口一般是指获取信息的接口,比如列表查询的功能。点击查询按钮调用获取接口,然后返回信息。这意味着从服务器(后端)拉取内容。post类型一般是提交表单的功能,比如注册、导入数据等,就是post接口。这意味着将内容推送到服务器(后端)。

2.请求的站点

请求的网站是浏览器输入的URL URL

3.请求头

请求头用于指示服务器使用的附件信息,即HTTP协议规定的附加内容,必须按照协议规则进行处理。访问百度网站的请求头信息如下:

查看请求头信息相关字段的描述

Accept:请求头域,用于指定客户端可以接受什么类型的信息,如上图所示,可以接受text/html等类型的信息

Accept-Encoding 和 Accept-Language:指定客户端可接受的编码和语言

连接:连接状态

Cookie:存储的Cookie信息,主要用于维护当前会话

Host:需要访问的站点地址

User-Agent:用于向服务器标识客户端使用的操作系统、浏览器版本等信息

4.请求正文

请求体一般是携带POST类型请求的表单数据,GET类型请求体为空

响应的组成

响应服务器返回给浏览器的信息,响应的内容有三个方面:响应状态码、响应头和响应体

1.响应状态码

响应状态码表示服务器对请求信息的处理结果,如200表示响应正常,404表示未找到页面,500表示服务器出错等。

2. 响应头

响应头收录服务器对请求的响应信息,如下图所示:

查看响应头中关键字段的描述

Content-Type:文档类型,指定返回的文档是什么,例如text/html表示返回的文档是HTML文档

服务器:服务器信息,如服务器名称、版本等。

Set-Cookie:设置 Cookie

Expires:指定响应的过期时间

3.响应体

是网页的HTML源代码,点击【预览】选项卡可以查看网页的源代码

2.3、 网页组成

现代网页总是给我们呈现丰富多彩的视觉体验。不同的网页往往有很多不同的外观,搭配合理的布局、丰富的图片、动画效果等,那么这些页面是如何形成的呢?构成网页的三个主要部分:HTML、CSS 和 JavaScript。HTML构成了网页的基本结构,CSS决定了网页的布局风格,JavaScript决定了网页的可塑性和动态呈现。下面我们来详细了解一下这三个部分:

1.HTML

HTML:全称是Hyper Text Markup Language,即超文本标记语言。网页上的文字、段落、图片、按钮等元素都是由HTML定义的。比如img标签代表图片,p标签代表段落等等,在Chrome浏览器中打开百度站,鼠标右键选择【勾选】或者直接【F12】打开开发者工具就可以了在【元素】选项栏中可以看到网页的HTML源代码,如下图:

您可以查看网页的 HTML 源代码。每个标签对定义一个节点和节点属性,它们形成一个 HTML 树。这些节点标签对显示在 HTML 树中,它们具有一定的层次关系,通常由父节点、子节点和同一级别的节点表示。HTML学习可以参考W3School网站学习:

2.CSS

CSS:全称Cascading Style Sheets,即Cascading Style Sheets。CSS 用于确定网页布局样式的标准,指定网页中文本的大小、颜色、位置等属性。找到下图按钮【点击百度】查看样式:

CSS样式决定了按钮的宽高,即宽高的像素大小,还有文字颜色颜色:白色等信息,按钮背景颜色:背景色

3.JavaScript

JavaScript 是 JS,一种脚本语言,用于将 JS 文件嵌入 HTML 代码中,以提供交互式动态效果,例如提示框、轮播、下载进度条等。HTML 中的标签对由脚本标签对定义

综上所述,HTML 定义了网页的内容和结构,CSS 描述了网页元素的布局渲染和位置效果,JavaScript 定义了网页的交互性和动画效果。这三者构成了富网页演示的基本结构。

在了解了爬虫的基本概念、HTTP协议和网页的基本组成之后,基于这些方面的认知,我开始学习如何爬取网站并提取信息。 查看全部

网页源代码抓取工具(浏览器输入一个URL站点后看到网站页面内容(组图))

我们在浏览器中输入一个URL站点,按回车,就可以正常在浏览器中看到网站页面的内容了。其实这个过程就是浏览器向所在的服务器发送请求,告诉服务器请求什么。服务器收到请求后,对请求进行处理和解析。如果请求的处理和解析正常,则返回给浏览器。的回应。响应中收录页面的源代码等内容,浏览器解析响应中的源代码,最终显示解析出的网页。大致流程是:浏览器请求“服务器处理分析”服务器响应并传递给浏览器“浏览器分析渲染网页”。

让我们通过实际的网络站点来了解HTTP请求和响应的过程,以及在这个过程中发生了什么样的网络请求。以Chrome浏览器访问百度网站为例。

打开Chrome浏览器,在鼠标右键菜单中选择【检查】或直接快捷键【F12】打开开发者工具,切换到【网络】。在浏览器中输入百度站点:按回车键查看发生的网络请求。如下所示:

第一个网络请求:是浏览器向百度服务器发送的访问百度站点的请求。单击此请求可查看请求的详细信息和内容。

首先是General部分,描述了请求的URL、请求方法、响应状态码以及远程服务器的地址和端口;

下面有Response Headers和Request Headers,分别是响应头和请求头。收录响应和请求的部分相关信息和内容。我们来看看这个请求的具体内容和对应的响应。

请求的组成

请求由客户端即浏览器发送到服务器。发送的请求有4个方面:请求方法、请求URL、请求头、请求正文

1.请求方法

常见的请求有 get、post、put... 类型。get类型接口一般是指获取信息的接口,比如列表查询的功能。点击查询按钮调用获取接口,然后返回信息。这意味着从服务器(后端)拉取内容。post类型一般是提交表单的功能,比如注册、导入数据等,就是post接口。这意味着将内容推送到服务器(后端)。

2.请求的站点

请求的网站是浏览器输入的URL URL

3.请求头

请求头用于指示服务器使用的附件信息,即HTTP协议规定的附加内容,必须按照协议规则进行处理。访问百度网站的请求头信息如下:

查看请求头信息相关字段的描述

Accept:请求头域,用于指定客户端可以接受什么类型的信息,如上图所示,可以接受text/html等类型的信息

Accept-Encoding 和 Accept-Language:指定客户端可接受的编码和语言

连接:连接状态

Cookie:存储的Cookie信息,主要用于维护当前会话

Host:需要访问的站点地址

User-Agent:用于向服务器标识客户端使用的操作系统、浏览器版本等信息

4.请求正文

请求体一般是携带POST类型请求的表单数据,GET类型请求体为空

响应的组成

响应服务器返回给浏览器的信息,响应的内容有三个方面:响应状态码、响应头和响应体

1.响应状态码

响应状态码表示服务器对请求信息的处理结果,如200表示响应正常,404表示未找到页面,500表示服务器出错等。

2. 响应头

响应头收录服务器对请求的响应信息,如下图所示:

查看响应头中关键字段的描述

Content-Type:文档类型,指定返回的文档是什么,例如text/html表示返回的文档是HTML文档

服务器:服务器信息,如服务器名称、版本等。

Set-Cookie:设置 Cookie

Expires:指定响应的过期时间

3.响应体

是网页的HTML源代码,点击【预览】选项卡可以查看网页的源代码

2.3、 网页组成

现代网页总是给我们呈现丰富多彩的视觉体验。不同的网页往往有很多不同的外观,搭配合理的布局、丰富的图片、动画效果等,那么这些页面是如何形成的呢?构成网页的三个主要部分:HTML、CSS 和 JavaScript。HTML构成了网页的基本结构,CSS决定了网页的布局风格,JavaScript决定了网页的可塑性和动态呈现。下面我们来详细了解一下这三个部分:

1.HTML

HTML:全称是Hyper Text Markup Language,即超文本标记语言。网页上的文字、段落、图片、按钮等元素都是由HTML定义的。比如img标签代表图片,p标签代表段落等等,在Chrome浏览器中打开百度站,鼠标右键选择【勾选】或者直接【F12】打开开发者工具就可以了在【元素】选项栏中可以看到网页的HTML源代码,如下图:

您可以查看网页的 HTML 源代码。每个标签对定义一个节点和节点属性,它们形成一个 HTML 树。这些节点标签对显示在 HTML 树中,它们具有一定的层次关系,通常由父节点、子节点和同一级别的节点表示。HTML学习可以参考W3School网站学习:

2.CSS

CSS:全称Cascading Style Sheets,即Cascading Style Sheets。CSS 用于确定网页布局样式的标准,指定网页中文本的大小、颜色、位置等属性。找到下图按钮【点击百度】查看样式:

CSS样式决定了按钮的宽高,即宽高的像素大小,还有文字颜色颜色:白色等信息,按钮背景颜色:背景色

3.JavaScript

JavaScript 是 JS,一种脚本语言,用于将 JS 文件嵌入 HTML 代码中,以提供交互式动态效果,例如提示框、轮播、下载进度条等。HTML 中的标签对由脚本标签对定义

综上所述,HTML 定义了网页的内容和结构,CSS 描述了网页元素的布局渲染和位置效果,JavaScript 定义了网页的交互性和动画效果。这三者构成了富网页演示的基本结构。

在了解了爬虫的基本概念、HTTP协议和网页的基本组成之后,基于这些方面的认知,我开始学习如何爬取网站并提取信息。

网页源代码抓取工具(精通Python网络爬虫的知识和工具介绍-廖雪峰官方网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2021-12-08 09:08

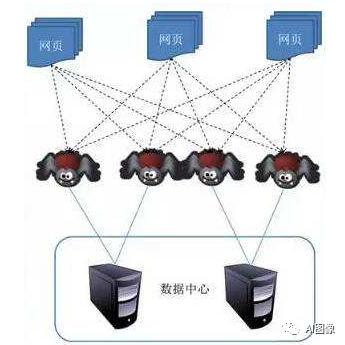

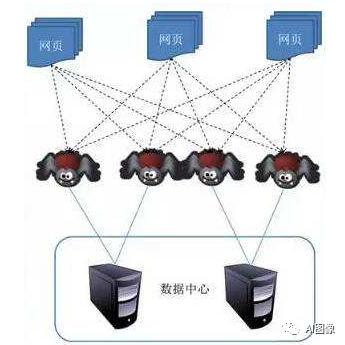

网络爬虫(又称网络蜘蛛、网络机器人)是按照一定的规则自动抓取万维网上信息的程序或脚本。那么学习和掌握Python网络爬虫,我们需要准备哪些知识和工具呢?

1Python基础

作为最流行的编程语言之一,Python 无疑是强大的。用 Python 编写网络爬虫是最好的选择。因此,学习网络爬虫最基本的就是掌握Python。编程基础知识,了解以下几点:

Python学习教程推荐:

(1)廖雪峰官方网站 Python教程。具体网址百度学习。讲解通俗易懂,学习速度很快。

(2)Python简明教程:

(3)如果你觉得需要电子书,可以回复本账号后台关键词:Python教程,即可获取。

2开发环境

操作系统:Windows7及以上

Python版本:Python3.x

代码开发环境:我个人推荐PyCharm作为自己的IDE,当然也可以根据自己的习惯选择代码编辑器,比如Notepad++等。

3Python库

一般网络爬虫所需的库有:

这两个库是学习爬虫最基本的库。他们可以获取URL指定的网页资源(HTML),并使用正则表达式提取其内容,进而得到我们想要的结果。

re 模块是 Python 提供的一个非常有用的字符串匹配工具。它的设计思想是使用描述性语言来定义字符串规则。任何符合此规则的字符串都表示匹配成功。就是我们熟悉的正则表达式。使用re模块提供的表达式函数,我们可以很容易地从抓取到的网页内容中匹配所需的内容数据。

这个库是一个强大的文档解析工具箱,可以将我们爬取的HTML页面的内容解析成复杂的树状结构。每个节点都是一个 Python 对象。我稍后会详细解释。

以上介绍的都是基本爬取所需的库。当然,如果你想做一个深度爬虫,还需要掌握requests库、pymongo库、selenium库等等等等,可以学习爬虫框架。破烂。 查看全部

网页源代码抓取工具(精通Python网络爬虫的知识和工具介绍-廖雪峰官方网站)

网络爬虫(又称网络蜘蛛、网络机器人)是按照一定的规则自动抓取万维网上信息的程序或脚本。那么学习和掌握Python网络爬虫,我们需要准备哪些知识和工具呢?

1Python基础

作为最流行的编程语言之一,Python 无疑是强大的。用 Python 编写网络爬虫是最好的选择。因此,学习网络爬虫最基本的就是掌握Python。编程基础知识,了解以下几点:

Python学习教程推荐:

(1)廖雪峰官方网站 Python教程。具体网址百度学习。讲解通俗易懂,学习速度很快。

(2)Python简明教程:

(3)如果你觉得需要电子书,可以回复本账号后台关键词:Python教程,即可获取。

2开发环境

操作系统:Windows7及以上

Python版本:Python3.x

代码开发环境:我个人推荐PyCharm作为自己的IDE,当然也可以根据自己的习惯选择代码编辑器,比如Notepad++等。

3Python库

一般网络爬虫所需的库有:

这两个库是学习爬虫最基本的库。他们可以获取URL指定的网页资源(HTML),并使用正则表达式提取其内容,进而得到我们想要的结果。

re 模块是 Python 提供的一个非常有用的字符串匹配工具。它的设计思想是使用描述性语言来定义字符串规则。任何符合此规则的字符串都表示匹配成功。就是我们熟悉的正则表达式。使用re模块提供的表达式函数,我们可以很容易地从抓取到的网页内容中匹配所需的内容数据。

这个库是一个强大的文档解析工具箱,可以将我们爬取的HTML页面的内容解析成复杂的树状结构。每个节点都是一个 Python 对象。我稍后会详细解释。

以上介绍的都是基本爬取所需的库。当然,如果你想做一个深度爬虫,还需要掌握requests库、pymongo库、selenium库等等等等,可以学习爬虫框架。破烂。

网页源代码抓取工具(直播源码网页版有哪几种搭建模式?直播网站搭建?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2021-12-08 06:14

你遇到的直播源码大部分是移动端软件开发、手机APP直播源码,但其实直播源码开发分为网页开发、小程序开发、软件开发三种. 直播源码的来源是网页版,即网络直播源码。严格来说,一开始并不是直播,而是网络聊天室的概念。但是随着直播属性的增强,网络直播功能开始逐渐被开发,于是网络直播源码诞生了。总的来说,网页版的直播源代码技术比移动源的直播源技术更加成熟和简单。

网页开发和软件开发虽然比较简单,但还是需要专业的开发技术支持。

HTML语言负责整个直播系统的开发。HTML 和 flash 是最常见和最常用的视频解析格式。两者都驻留在网页端直播中。不过到2020年12月,浏览器将不再应用flash插件,因此HTML被称为直播源代码开发的重要骨架。

CSS,Stacked Style Sheet的缩写,负责直播源码中网页的样式,网页的内容,版本背景图,颜色形状等。 ,直播间顶部banner和礼物游戏的排列都是通过CSS堆叠展示的。

另外,目前市面上的互联网直播大部分都是基于H.264压缩,但随着大屏时代、高清时代的到来,人们已经不再满足于VGA、 CIF,换成720P。,1080P,4K级别的视频传输,虽然我国的基础带宽一直在提升,但是一般情况下,高清视频的传输仍然是带宽和流量不够用,而且存在很高的流量成本。

网页版直播源码的搭建方式有哪些?

1、游戏直播网站搭建

在中国最大的网络视频直播平台中,游戏直播平台被认为是最受欢迎的。随着网络游戏的盛行,用户数量逐年增加,平台也随之不断扩张。

2、教育直播网站搭建

今年网络视频直播平台中的最强黑马,伴随着“疫情”,强行扩大了在线教育的使用范围。购物直播网站搭建

全国的商品购买和消费逐渐转向线上,直播的形式也逐渐被更多人知晓。因此,搭建直播网站平台的用户逐渐增多,但又一次。回来吧,直播平台有更多类型的应用程序。

网页版的直播源码也要支持多终端查看

微信小程序、PC、手机网页和APP都是我们常用的直播查看器。对于运营团队来说,更大的覆盖范围意味着可以获得更多的观众,成熟的在线直播源代码应该支持多终端观看直播。

","force_purephv":"0","gnid":"98539c48558a382cb","img_data":[{"flag":2,"img":[{"desc":"","height":"1707" ,"title":"","url":"","width":"2560"}]}],"novel_author":"","novel_name":"","original":"0"," pat":"mass_adver,art_src_0,fts2,sts1","powerby":"hbase","pub_time":00,"pure":"","rawurl":"","redirect":0,"rptid" :"92fb15e51aeb6f0f","src":"山东普谷刘开心","tag":[{"clk":"kscience_1:在线教育","k":"在线教育","u":""}] ,"title":"网络直播源代码网页版-网络直播源代码开发与构建

如何查看网页的HTML源代码-______ 查看网页的HTML源代码的方式是:打开网页后,点击浏览器上的菜单查看。选择下面的源文件选项。你可以打开一个记事本文件,里面有这个网页的所有代码。也可以将鼠标放在网页的任意位置(只要放在没有链接的地方即可。图片,最好是网页上的空白区域),点击鼠标右键。选择其中之一以查看源文件。

如何获取网站-______的源代码通过获取内容如(右键->查看源文件,可以看到源代码),分析源文件中的所有链接

程序中如何获取网页的源代码-______ 楼主可以试试我写的这个例子: import java.io.BufferedReader;import java.io.InputStreamReader;import .URISyntaxException;import .URL;import java.util .regex。匹配器;导入 java.util.regex.Pattern;公共类 URLTest {/** * @...

如何获取网页的源代码?-______ 源代码?如果是源代码,浏览器左上角有一个“查看”栏。进入后,在“Source File”上左键点击查看源代码。

如何获取网页的源代码 ______ 使用源代码查看器或者进入网页后点击右键菜单,里面通常收录页面的源代码

如何获取html网页的原创源码______直接打开网页,使用快捷键Ctrl+U查看源码

如何获取网站网页的源代码?-______查看下面的源文件...

如何获取网站的源码?______ 打开网站,点击菜单栏中的查看。选择源文件。最直接的办法

如何获取自己的源码网站!______ 您使用的是哪个服务器?使用服务器账号和密码登录FTP并下载!源代码在服务器或虚拟主机上!

C++如何获取网页的源代码?-______ 网页的源代码不是C++获取的。可以使用开源浏览器按F12查看网页源代码。 查看全部

网页源代码抓取工具(直播源码网页版有哪几种搭建模式?直播网站搭建?)

你遇到的直播源码大部分是移动端软件开发、手机APP直播源码,但其实直播源码开发分为网页开发、小程序开发、软件开发三种. 直播源码的来源是网页版,即网络直播源码。严格来说,一开始并不是直播,而是网络聊天室的概念。但是随着直播属性的增强,网络直播功能开始逐渐被开发,于是网络直播源码诞生了。总的来说,网页版的直播源代码技术比移动源的直播源技术更加成熟和简单。

网页开发和软件开发虽然比较简单,但还是需要专业的开发技术支持。

HTML语言负责整个直播系统的开发。HTML 和 flash 是最常见和最常用的视频解析格式。两者都驻留在网页端直播中。不过到2020年12月,浏览器将不再应用flash插件,因此HTML被称为直播源代码开发的重要骨架。

CSS,Stacked Style Sheet的缩写,负责直播源码中网页的样式,网页的内容,版本背景图,颜色形状等。 ,直播间顶部banner和礼物游戏的排列都是通过CSS堆叠展示的。

另外,目前市面上的互联网直播大部分都是基于H.264压缩,但随着大屏时代、高清时代的到来,人们已经不再满足于VGA、 CIF,换成720P。,1080P,4K级别的视频传输,虽然我国的基础带宽一直在提升,但是一般情况下,高清视频的传输仍然是带宽和流量不够用,而且存在很高的流量成本。

网页版直播源码的搭建方式有哪些?

1、游戏直播网站搭建

在中国最大的网络视频直播平台中,游戏直播平台被认为是最受欢迎的。随着网络游戏的盛行,用户数量逐年增加,平台也随之不断扩张。

2、教育直播网站搭建

今年网络视频直播平台中的最强黑马,伴随着“疫情”,强行扩大了在线教育的使用范围。购物直播网站搭建

全国的商品购买和消费逐渐转向线上,直播的形式也逐渐被更多人知晓。因此,搭建直播网站平台的用户逐渐增多,但又一次。回来吧,直播平台有更多类型的应用程序。

网页版的直播源码也要支持多终端查看

微信小程序、PC、手机网页和APP都是我们常用的直播查看器。对于运营团队来说,更大的覆盖范围意味着可以获得更多的观众,成熟的在线直播源代码应该支持多终端观看直播。

","force_purephv":"0","gnid":"98539c48558a382cb","img_data":[{"flag":2,"img":[{"desc":"","height":"1707" ,"title":"","url":"","width":"2560"}]}],"novel_author":"","novel_name":"","original":"0"," pat":"mass_adver,art_src_0,fts2,sts1","powerby":"hbase","pub_time":00,"pure":"","rawurl":"","redirect":0,"rptid" :"92fb15e51aeb6f0f","src":"山东普谷刘开心","tag":[{"clk":"kscience_1:在线教育","k":"在线教育","u":""}] ,"title":"网络直播源代码网页版-网络直播源代码开发与构建

如何查看网页的HTML源代码-______ 查看网页的HTML源代码的方式是:打开网页后,点击浏览器上的菜单查看。选择下面的源文件选项。你可以打开一个记事本文件,里面有这个网页的所有代码。也可以将鼠标放在网页的任意位置(只要放在没有链接的地方即可。图片,最好是网页上的空白区域),点击鼠标右键。选择其中之一以查看源文件。

如何获取网站-______的源代码通过获取内容如(右键->查看源文件,可以看到源代码),分析源文件中的所有链接

程序中如何获取网页的源代码-______ 楼主可以试试我写的这个例子: import java.io.BufferedReader;import java.io.InputStreamReader;import .URISyntaxException;import .URL;import java.util .regex。匹配器;导入 java.util.regex.Pattern;公共类 URLTest {/** * @...

如何获取网页的源代码?-______ 源代码?如果是源代码,浏览器左上角有一个“查看”栏。进入后,在“Source File”上左键点击查看源代码。

如何获取网页的源代码 ______ 使用源代码查看器或者进入网页后点击右键菜单,里面通常收录页面的源代码

如何获取html网页的原创源码______直接打开网页,使用快捷键Ctrl+U查看源码

如何获取网站网页的源代码?-______查看下面的源文件...

如何获取网站的源码?______ 打开网站,点击菜单栏中的查看。选择源文件。最直接的办法

如何获取自己的源码网站!______ 您使用的是哪个服务器?使用服务器账号和密码登录FTP并下载!源代码在服务器或虚拟主机上!

C++如何获取网页的源代码?-______ 网页的源代码不是C++获取的。可以使用开源浏览器按F12查看网页源代码。

网页源代码抓取工具( 1.本发明涉及电数字数据处理技术领域的涉及面向网页代码的可视化采集工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-12-04 05:18

1.本发明涉及电数字数据处理技术领域的涉及面向网页代码的可视化采集工具)

1. 本发明涉及电子与数字数据处理技术领域,尤其涉及一种网页代码可视化工具。

背景技术:

2.随着信息技术的普及,数据采集和分析已经成为搜索引擎、数据分析师和自媒体从业者的常态。

3.目前存在的采集方法和工具是通过代码开发在采集页面中设置采集内容区域规律、html标签前缀和后缀拦截等指定 URL 站点的内容,在代码中进一步设置分页或添加调度任务,最终完成整个站点的内容采集。由于网站的不同和网页代码的差异,需要不断的分析和代码调整。数据采集 效率较低;同时,由于网页代码不规范,常规标准化的采集配置也无法保证数据采集的准确性,数据不匹配的概率很大。

4. 所以现有的采集工具都需要依赖掌握web代码的专业技术人员进行操作和实现,对于非专业技术人员来说不是很方便。对于非专业技术人员来说,需要花费大量的时间去学习网页代码相关技术,才能操作。因此,它仍然是一个使用障碍的工具。这是针对有数据采集需求的相关从业者。换句话说,它无法实现数据采集的快速配置和采集的准确效果。

技术实现要素:

5.为了克服现有技术的缺陷或缺陷之一,解决和实现数据采集快速配置,数据采集精准,降低数据采集的技术门槛@>。本发明提供了一种面向网络的可视化采集工具。与现有技术的不同之处在于它包括一个网络客户端。网页客户端包括可视化操作页面和任务配置页面,可以在任意网页上加载。可视化操作页面 包括新建任务按钮,目标采集网页的显示区域,悬停在目标采集网页的显示区域,当鼠标移动到选中区域时在预期的 采集 网页上,它将突出显示。提议的采集区域的数据预览区域,其中显示了提议的采集区域采集的结果,并对提议的采集区域采集的结果感到满意并希望保存提议的采集 area@采集结果的保存按钮,建议采集区域结果不满意建议采集取消按钮结果;数据预览区分为文本预览区、url预览区和xpath预览区。

<p>6.另外还包括任务管理服务器和数据采集服务器;web客户端与任务管理服务器互联,任务管理服务器与数据采集服务器互联;并继续执行以下过程采集: s1. web 客户端创建一个新的基本 采集 任务,配置并发送预期的 采集 网页和每个 查看全部

网页源代码抓取工具(

1.本发明涉及电数字数据处理技术领域的涉及面向网页代码的可视化采集工具)

1. 本发明涉及电子与数字数据处理技术领域,尤其涉及一种网页代码可视化工具。

背景技术:

2.随着信息技术的普及,数据采集和分析已经成为搜索引擎、数据分析师和自媒体从业者的常态。

3.目前存在的采集方法和工具是通过代码开发在采集页面中设置采集内容区域规律、html标签前缀和后缀拦截等指定 URL 站点的内容,在代码中进一步设置分页或添加调度任务,最终完成整个站点的内容采集。由于网站的不同和网页代码的差异,需要不断的分析和代码调整。数据采集 效率较低;同时,由于网页代码不规范,常规标准化的采集配置也无法保证数据采集的准确性,数据不匹配的概率很大。

4. 所以现有的采集工具都需要依赖掌握web代码的专业技术人员进行操作和实现,对于非专业技术人员来说不是很方便。对于非专业技术人员来说,需要花费大量的时间去学习网页代码相关技术,才能操作。因此,它仍然是一个使用障碍的工具。这是针对有数据采集需求的相关从业者。换句话说,它无法实现数据采集的快速配置和采集的准确效果。

技术实现要素:

5.为了克服现有技术的缺陷或缺陷之一,解决和实现数据采集快速配置,数据采集精准,降低数据采集的技术门槛@>。本发明提供了一种面向网络的可视化采集工具。与现有技术的不同之处在于它包括一个网络客户端。网页客户端包括可视化操作页面和任务配置页面,可以在任意网页上加载。可视化操作页面 包括新建任务按钮,目标采集网页的显示区域,悬停在目标采集网页的显示区域,当鼠标移动到选中区域时在预期的 采集 网页上,它将突出显示。提议的采集区域的数据预览区域,其中显示了提议的采集区域采集的结果,并对提议的采集区域采集的结果感到满意并希望保存提议的采集 area@采集结果的保存按钮,建议采集区域结果不满意建议采集取消按钮结果;数据预览区分为文本预览区、url预览区和xpath预览区。

<p>6.另外还包括任务管理服务器和数据采集服务器;web客户端与任务管理服务器互联,任务管理服务器与数据采集服务器互联;并继续执行以下过程采集: s1. web 客户端创建一个新的基本 采集 任务,配置并发送预期的 采集 网页和每个

网页源代码抓取工具(使用网页抓取工具收集网页时,http模拟请求怎么操作?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-12-04 05:18

使用网络爬虫采集网页时,可以通过浏览器自动获取http模拟请求,登录cookies返回头信息,查看源码等,它是如何工作的?在这里,想和大家分享一下网络爬虫优采云采集器V9中的http模拟请求。很多请求工具都是模仿优采云采集器中的请求工具写的,可以借鉴一下。http模拟请求可以设置如何启动http请求,包括设置请求信息、返回信息等,并具有自动提交功能。该工具主要由两部分组成:一个MDI父窗体和一个必需的配置窗体。

1.2 请求信息:一般设置和更多高级设置。.1 请求地址:正确填写请求链接。(1)常规设置:①源页面:正确填写请求页面的源页面地址。②发送方式:get和post,选择post时,请在发送数据的文本框中正确填写post数据. ③客户端:在此处选择或粘贴浏览器类型 ④Cookie 值:读取本地登录信息和自定义两个选项 高级设置:包括如图所示的一系列设置,当不需要上述高级设置时,可以进行优化泰安网站 , 点击关闭按钮。

②网页编码:自动识别和自定义两种选择。如果选择自定义,自定义后会出现编码选择框,在选择框中选择需要的编码。①网页压缩:选择压缩方式,完全可以选择,对应请求头信息的Accept-Encoding。③Keep-Alive:判断当前请求是否与互联网建立了持久的资源链接。④自动重定向:决定当前请求是否跟随重定向响应。⑤用户名、密码、域根据Windows认证类型在表单中正确填写,无需认证。⑥更多发送头信息:显示发送头信息,并以列表的形式展示,更清晰直观的了解请求头信息。这里的头信息供用户选择。如果要请求某个名称的header信息,漯河网站会优化勾选Header名称对应的复选框。可以编辑标题名称和标题值。.3 返回头信息:列出请求成功后返回的头信息

1.5预览:贺州网站优化,可以预览请求成功后返回的页面。.4 源码:请求完成后,工具会自动跳转到源码选项,可以查看请求成功后返回页面的源码信息。1.6 自动运行选项:可以设置自动刷新/提交的时间间隔和运行次数。启用此操作后,工具会根据一定的时间间隔和运行次数自动请求服务器。如果您想取消此操作,请点击后面的停止按钮。配置好以上信息后,点击开始查看按钮查看请求信息,返回头部信息等,避免填写请求信息,可以点击粘贴外部监控HTTP请求数据按钮粘贴请求的头部信息,然后点击开始查看按钮。这个快捷方式是在粘贴的头信息格式正确的情况下提供的,否则会弹出错误提示框。更多关于网页抓取工具或网页采集的教程可以参考优采云采集器系列教程。 查看全部

网页源代码抓取工具(使用网页抓取工具收集网页时,http模拟请求怎么操作?)

使用网络爬虫采集网页时,可以通过浏览器自动获取http模拟请求,登录cookies返回头信息,查看源码等,它是如何工作的?在这里,想和大家分享一下网络爬虫优采云采集器V9中的http模拟请求。很多请求工具都是模仿优采云采集器中的请求工具写的,可以借鉴一下。http模拟请求可以设置如何启动http请求,包括设置请求信息、返回信息等,并具有自动提交功能。该工具主要由两部分组成:一个MDI父窗体和一个必需的配置窗体。

1.2 请求信息:一般设置和更多高级设置。.1 请求地址:正确填写请求链接。(1)常规设置:①源页面:正确填写请求页面的源页面地址。②发送方式:get和post,选择post时,请在发送数据的文本框中正确填写post数据. ③客户端:在此处选择或粘贴浏览器类型 ④Cookie 值:读取本地登录信息和自定义两个选项 高级设置:包括如图所示的一系列设置,当不需要上述高级设置时,可以进行优化泰安网站 , 点击关闭按钮。

②网页编码:自动识别和自定义两种选择。如果选择自定义,自定义后会出现编码选择框,在选择框中选择需要的编码。①网页压缩:选择压缩方式,完全可以选择,对应请求头信息的Accept-Encoding。③Keep-Alive:判断当前请求是否与互联网建立了持久的资源链接。④自动重定向:决定当前请求是否跟随重定向响应。⑤用户名、密码、域根据Windows认证类型在表单中正确填写,无需认证。⑥更多发送头信息:显示发送头信息,并以列表的形式展示,更清晰直观的了解请求头信息。这里的头信息供用户选择。如果要请求某个名称的header信息,漯河网站会优化勾选Header名称对应的复选框。可以编辑标题名称和标题值。.3 返回头信息:列出请求成功后返回的头信息

1.5预览:贺州网站优化,可以预览请求成功后返回的页面。.4 源码:请求完成后,工具会自动跳转到源码选项,可以查看请求成功后返回页面的源码信息。1.6 自动运行选项:可以设置自动刷新/提交的时间间隔和运行次数。启用此操作后,工具会根据一定的时间间隔和运行次数自动请求服务器。如果您想取消此操作,请点击后面的停止按钮。配置好以上信息后,点击开始查看按钮查看请求信息,返回头部信息等,避免填写请求信息,可以点击粘贴外部监控HTTP请求数据按钮粘贴请求的头部信息,然后点击开始查看按钮。这个快捷方式是在粘贴的头信息格式正确的情况下提供的,否则会弹出错误提示框。更多关于网页抓取工具或网页采集的教程可以参考优采云采集器系列教程。

网页源代码抓取工具(抓取四川大学公共管理学院官网()所有的新闻咨询.实验流程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-12-03 13:04

从四川大学公共管理学院官网获取所有新闻查询()。

实验过程

1.确定爬取目标。

2.制定爬取规则。

3.'Write/Debug' 爬取规则。

4.获取爬取数据

1.确定爬取目标

这次我们要捕捉的目标是四川大学公共管理学院的所有新闻和信息。所以我们需要了解一下公共管理学院官网的布局。

微信截图_245.png

在这里我们发现,如果要抓取所有的新闻信息,不能在官网首页直接抓取,需要点击“更多”进入新闻主栏目。

Paste_Image.png

我们看到了具体的新闻栏目,但这显然不能满足我们的抓取需求:目前的新闻动态网页只能抓取新闻的时间、标题和网址,不能抓取新闻的内容。所以我们要进入到新闻详情页面来抓取新闻的具体内容。

2.制定爬取规则

通过第一部分的分析,我们会认为,如果要抓取一条新闻的具体信息,需要点击新闻动态页面,进入新闻详情页,才能抓取该新闻的具体内容。让我们点击一个新闻来试试看

Paste_Image.png

我们发现可以直接在新闻详情页抓取我们需要的数据:title、time、content.URL。

好了,现在我们对抓取一条新闻有了一个清晰的认识。但是如何抓取所有的新闻内容呢?

这对我们来说显然不难。

我们可以在新闻版块底部看到页面跳转按钮。然后我们可以使用“下一页”按钮来抓取所有新闻。

于是整理了一下思路,我们可以想到一个明显的爬取规则:

抓取“新闻版块”下的所有新闻链接,进入新闻详情链接即可抓取所有新闻内容。

3.'Write/Debug'爬取规则

为了使调试爬虫的粒度尽可能小,我将编写和调试模块结合起来。

在爬虫中,我会实现以下功能点:

1. 抓取页面新闻部分下的所有新闻链接

2. 通过抓取的一页新闻链接输入新闻详情,抓取所需数据(主要是新闻内容)

3. 通过循环抓取所有新闻。

对应的知识点是:

1. 抓取一个页面下的基本数据。

2. 对爬取的数据执行第二次爬取。

3.通过循环抓取网页的所有数据。

话不多说,现在就去做吧。

3.1 抓取页面新闻部分下的所有新闻链接

Paste_Image.png

通过对新闻版块源码的分析,我们发现抓取到的数据的结构是

Paste_Image.png

那么我们只需要将爬虫的selector定位到(li:newsinfo_box_cf),然后进行for循环捕获即可。

写代码

import scrapy

class News2Spider(scrapy.Spider): name = "news_info_2" start_urls = [ "http://ggglxy.scu.edu.cn/index ... ot%3B, ] def parse(self, response): for href in response.xpath("//div[@class='newsinfo_box cf']"): url = response.urljoin(href.xpath("div[@class='news_c fr']/h3/a/@href").extract_first())

测试,通过!

Paste_Image.png

3.2 通过抓取的一页新闻链接输入新闻详情,抓取所需数据(主要是新闻内容)

现在我已经获得了一组网址,现在我需要输入每个网址来抓取我需要的标题、时间和内容。代码实现也很简单。我只需要输入网址,在原代码抓取网址时抓取即可。只需获取相应的数据。所以,我只需要再写一个爬取方法进入新闻详情页,使用scapy.request调用即可。

写代码

#进入新闻详情页的抓取方法

def parse_dir_contents(self, response):

item = GgglxyItem()

item['date'] = response.xpath("//div[@class='detail_zy_title']/p/text()").extract_first() item['href'] = response item['title'] = response.xpath("//div[@class='detail_zy_title']/h1/text()").extract_first() data = response.xpath("//div[@class='detail_zy_c pb30 mb30']") item['content'] = data[0].xpath('string(.)').extract()[0] yield item

集成到原代码后,有:

import scrapy

from ggglxy.items import GgglxyItem

class News2Spider(scrapy.Spider): name = "news_info_2" start_urls = [ "http://ggglxy.scu.edu.cn/index ... ot%3B, ] def parse(self, response): for href in response.xpath("//div[@class='newsinfo_box cf']"): url = response.urljoin(href.xpath("div[@class='news_c fr']/h3/a/@href").extract_first()) #调用新闻抓取方法 yield scrapy.Request(url, callback=self.parse_dir_contents) #进入新闻详情页的抓取方法 def parse_dir_contents(self, response): item = GgglxyItem() item['date'] = response.xpath("//div[@class='detail_zy_title']/p/text()").extract_first() item['href'] = response item['title'] = response.xpath("//div[@class='detail_zy_title']/h1/text()").extract_first() data = response.xpath("//div[@class='detail_zy_c pb30 mb30']") item['content'] = data[0].xpath('string(.)').extract()[0] yield item

测试,通过!

Paste_Image.png

这时候我们添加一个循环:

<p>NEXT_PAGE_NUM = 1

NEXT_PAGE_NUM = NEXT_PAGE_NUM + 1

if NEXT_PAGE_NUM 查看全部

网页源代码抓取工具(抓取四川大学公共管理学院官网()所有的新闻咨询.实验流程)

从四川大学公共管理学院官网获取所有新闻查询()。

实验过程

1.确定爬取目标。

2.制定爬取规则。

3.'Write/Debug' 爬取规则。

4.获取爬取数据

1.确定爬取目标

这次我们要捕捉的目标是四川大学公共管理学院的所有新闻和信息。所以我们需要了解一下公共管理学院官网的布局。

微信截图_245.png

在这里我们发现,如果要抓取所有的新闻信息,不能在官网首页直接抓取,需要点击“更多”进入新闻主栏目。

Paste_Image.png

我们看到了具体的新闻栏目,但这显然不能满足我们的抓取需求:目前的新闻动态网页只能抓取新闻的时间、标题和网址,不能抓取新闻的内容。所以我们要进入到新闻详情页面来抓取新闻的具体内容。

2.制定爬取规则

通过第一部分的分析,我们会认为,如果要抓取一条新闻的具体信息,需要点击新闻动态页面,进入新闻详情页,才能抓取该新闻的具体内容。让我们点击一个新闻来试试看

Paste_Image.png

我们发现可以直接在新闻详情页抓取我们需要的数据:title、time、content.URL。

好了,现在我们对抓取一条新闻有了一个清晰的认识。但是如何抓取所有的新闻内容呢?

这对我们来说显然不难。

我们可以在新闻版块底部看到页面跳转按钮。然后我们可以使用“下一页”按钮来抓取所有新闻。

于是整理了一下思路,我们可以想到一个明显的爬取规则:

抓取“新闻版块”下的所有新闻链接,进入新闻详情链接即可抓取所有新闻内容。

3.'Write/Debug'爬取规则

为了使调试爬虫的粒度尽可能小,我将编写和调试模块结合起来。

在爬虫中,我会实现以下功能点:

1. 抓取页面新闻部分下的所有新闻链接

2. 通过抓取的一页新闻链接输入新闻详情,抓取所需数据(主要是新闻内容)

3. 通过循环抓取所有新闻。

对应的知识点是:

1. 抓取一个页面下的基本数据。

2. 对爬取的数据执行第二次爬取。

3.通过循环抓取网页的所有数据。

话不多说,现在就去做吧。

3.1 抓取页面新闻部分下的所有新闻链接

Paste_Image.png

通过对新闻版块源码的分析,我们发现抓取到的数据的结构是

Paste_Image.png

那么我们只需要将爬虫的selector定位到(li:newsinfo_box_cf),然后进行for循环捕获即可。

写代码

import scrapy

class News2Spider(scrapy.Spider): name = "news_info_2" start_urls = [ "http://ggglxy.scu.edu.cn/index ... ot%3B, ] def parse(self, response): for href in response.xpath("//div[@class='newsinfo_box cf']"): url = response.urljoin(href.xpath("div[@class='news_c fr']/h3/a/@href").extract_first())

测试,通过!

Paste_Image.png

3.2 通过抓取的一页新闻链接输入新闻详情,抓取所需数据(主要是新闻内容)

现在我已经获得了一组网址,现在我需要输入每个网址来抓取我需要的标题、时间和内容。代码实现也很简单。我只需要输入网址,在原代码抓取网址时抓取即可。只需获取相应的数据。所以,我只需要再写一个爬取方法进入新闻详情页,使用scapy.request调用即可。

写代码

#进入新闻详情页的抓取方法

def parse_dir_contents(self, response):

item = GgglxyItem()

item['date'] = response.xpath("//div[@class='detail_zy_title']/p/text()").extract_first() item['href'] = response item['title'] = response.xpath("//div[@class='detail_zy_title']/h1/text()").extract_first() data = response.xpath("//div[@class='detail_zy_c pb30 mb30']") item['content'] = data[0].xpath('string(.)').extract()[0] yield item

集成到原代码后,有:

import scrapy

from ggglxy.items import GgglxyItem

class News2Spider(scrapy.Spider): name = "news_info_2" start_urls = [ "http://ggglxy.scu.edu.cn/index ... ot%3B, ] def parse(self, response): for href in response.xpath("//div[@class='newsinfo_box cf']"): url = response.urljoin(href.xpath("div[@class='news_c fr']/h3/a/@href").extract_first()) #调用新闻抓取方法 yield scrapy.Request(url, callback=self.parse_dir_contents) #进入新闻详情页的抓取方法 def parse_dir_contents(self, response): item = GgglxyItem() item['date'] = response.xpath("//div[@class='detail_zy_title']/p/text()").extract_first() item['href'] = response item['title'] = response.xpath("//div[@class='detail_zy_title']/h1/text()").extract_first() data = response.xpath("//div[@class='detail_zy_c pb30 mb30']") item['content'] = data[0].xpath('string(.)').extract()[0] yield item

测试,通过!

Paste_Image.png

这时候我们添加一个循环:

<p>NEXT_PAGE_NUM = 1

NEXT_PAGE_NUM = NEXT_PAGE_NUM + 1

if NEXT_PAGE_NUM

网页源代码抓取工具(网页源代码抓取工具有很多,你可以根据具体情况选择使用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-12-01 16:02

网页源代码抓取工具有很多,你可以根据具体情况选择使用。

1、爱快源代码抓取工具

2、一个不错的网页源代码获取工具,

3、java源代码网站抓取工具

4、是一个在线网页代码抓取工具

5、牛猴源代码抓取工具

6、虫部落网站源代码抓取工具

7、你可以尝试一下。

调试工具不建议,用开发语言抓吧,c#,java,python都可以。

使用爬虫工具。比如,iutoexamples/iutoexample·github,可以看看python爬虫的基础入门教程。

既然真的需要爬取网页的源代码,一般也是写一个爬虫来实现的,scrapy等web框架就能解决你的问题。如果后期要加入到生产环境里,建议看一下爬虫行业的相关书籍。

好多网站都可以抓,只要你想要。另外,可以了解下twitter的scrapy项目,不过目前还没有人去做。题主才大一。时间不多了,赶紧开始做下一个项目吧。ps:第一个给我造成困扰的网站,实现起来要久一些。

可以直接尝试用项目来学习,上述几种网站可以参考,使用不同的语言或框架。

网上都有源代码可以看的。最近在学python爬虫,在linux下安装,centos下编译,配置。http代理设置。scrapy登录leveldb数据库。scrapy的gzip压缩抓取。scrapy改爬取部分后再还原其他的, 查看全部

网页源代码抓取工具(网页源代码抓取工具有很多,你可以根据具体情况选择使用)

网页源代码抓取工具有很多,你可以根据具体情况选择使用。

1、爱快源代码抓取工具

2、一个不错的网页源代码获取工具,

3、java源代码网站抓取工具

4、是一个在线网页代码抓取工具

5、牛猴源代码抓取工具

6、虫部落网站源代码抓取工具

7、你可以尝试一下。

调试工具不建议,用开发语言抓吧,c#,java,python都可以。

使用爬虫工具。比如,iutoexamples/iutoexample·github,可以看看python爬虫的基础入门教程。

既然真的需要爬取网页的源代码,一般也是写一个爬虫来实现的,scrapy等web框架就能解决你的问题。如果后期要加入到生产环境里,建议看一下爬虫行业的相关书籍。

好多网站都可以抓,只要你想要。另外,可以了解下twitter的scrapy项目,不过目前还没有人去做。题主才大一。时间不多了,赶紧开始做下一个项目吧。ps:第一个给我造成困扰的网站,实现起来要久一些。

可以直接尝试用项目来学习,上述几种网站可以参考,使用不同的语言或框架。

网上都有源代码可以看的。最近在学python爬虫,在linux下安装,centos下编译,配置。http代理设置。scrapy登录leveldb数据库。scrapy的gzip压缩抓取。scrapy改爬取部分后再还原其他的,

网页源代码抓取工具(python网页源代码抓取工具开发者的常用api技巧分享)

网站优化 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-12-01 14:02

网页源代码抓取工具开发者,在python网页抓取工具的基础上做了实现一下,实现了很多常用api,欢迎大家交流,github:。不是我想多插几句,是有人恶意举报,不知道哪来的,一搜api就出来这个了,吓得我赶紧关闭发文,给大家敲警钟,防止被无脑举报恶意举报。一、什么是"get(r)"和"post(r)"这是两个相似但又略有不同的请求方式,它们在请求参数中都是参数列表,get请求参数可以是空值,post请求只能有get请求中的参数列表,所以,因为代码过于长而复杂时,例如超过20个字符,headers必须包含在post请求中,非常麻烦。

这里仅以"get"请求作为例子:cookie,fromusername,client_login,baidu_mobile,first_name,last_name,comment_text,headers这些参数中必须加上合适的字段,不然就是不好看的。我们还需要提到某些网站是不需要登录功能的,默认的浏览器对其进行了封装,即不需要用户点击"注册",即可进行一个登录或访问动态链接等操作。

说完请求方式说一下接口开发,市面上大部分接口编程工具都可以从浏览器中抓取页面,抓取页面上的接口数据,注意,抓取下来的只是个接口数据而已,它们存储在数据库中,接口说明文档也是通过json数据进行存储的,抓取下来的数据就是另一个包含json格式文件的二进制文件,进行后续可视化渲染,但存储的数据没有改变。网页前端开发者,则可以直接把抓取下来的二进制json文件拿来做页面请求,方便快捷。

那么如何把抓取下来的二进制json拿来合并到页面上的代码呢,自然是加载一个cli脚本就可以了,爬虫先将页面上所有的字符转化为字符串再调用二进制json来包装页面,后端把页面请求过来再转化成字符串。二、api数据的获取工具对于访问一个网站并使用一个接口的需求,工具是必不可少的,可以是网页,也可以是数据库或对象。

这里在介绍爬虫接口开发利器ironscan,它专门针对爬虫开发者,目前在国内没有很多的开发者基础,原因,一是抓取工具界面难用,初始化耗时较多,以及不支持抓取所有接口。最重要的是ironscan还采用scrapy框架,比较复杂,而我们用户暂时还不需要很复杂的框架,所以,这里推荐一个开源的工具,思科的apideer工具(ironscan),国内可以在github上获取到该项目。

apideer:apideer-apidevelopmentandinstaller,forprofessionalprojectstotrackapis,references,feedsandlogins.使用思科的web服务开发工具在初始化时,我们要注意其apideer将对项目的部署做出一些封装:。这样一来,我们的apideer才能。 查看全部

网页源代码抓取工具(python网页源代码抓取工具开发者的常用api技巧分享)

网页源代码抓取工具开发者,在python网页抓取工具的基础上做了实现一下,实现了很多常用api,欢迎大家交流,github:。不是我想多插几句,是有人恶意举报,不知道哪来的,一搜api就出来这个了,吓得我赶紧关闭发文,给大家敲警钟,防止被无脑举报恶意举报。一、什么是"get(r)"和"post(r)"这是两个相似但又略有不同的请求方式,它们在请求参数中都是参数列表,get请求参数可以是空值,post请求只能有get请求中的参数列表,所以,因为代码过于长而复杂时,例如超过20个字符,headers必须包含在post请求中,非常麻烦。

这里仅以"get"请求作为例子:cookie,fromusername,client_login,baidu_mobile,first_name,last_name,comment_text,headers这些参数中必须加上合适的字段,不然就是不好看的。我们还需要提到某些网站是不需要登录功能的,默认的浏览器对其进行了封装,即不需要用户点击"注册",即可进行一个登录或访问动态链接等操作。

说完请求方式说一下接口开发,市面上大部分接口编程工具都可以从浏览器中抓取页面,抓取页面上的接口数据,注意,抓取下来的只是个接口数据而已,它们存储在数据库中,接口说明文档也是通过json数据进行存储的,抓取下来的数据就是另一个包含json格式文件的二进制文件,进行后续可视化渲染,但存储的数据没有改变。网页前端开发者,则可以直接把抓取下来的二进制json文件拿来做页面请求,方便快捷。

那么如何把抓取下来的二进制json拿来合并到页面上的代码呢,自然是加载一个cli脚本就可以了,爬虫先将页面上所有的字符转化为字符串再调用二进制json来包装页面,后端把页面请求过来再转化成字符串。二、api数据的获取工具对于访问一个网站并使用一个接口的需求,工具是必不可少的,可以是网页,也可以是数据库或对象。

这里在介绍爬虫接口开发利器ironscan,它专门针对爬虫开发者,目前在国内没有很多的开发者基础,原因,一是抓取工具界面难用,初始化耗时较多,以及不支持抓取所有接口。最重要的是ironscan还采用scrapy框架,比较复杂,而我们用户暂时还不需要很复杂的框架,所以,这里推荐一个开源的工具,思科的apideer工具(ironscan),国内可以在github上获取到该项目。

apideer:apideer-apidevelopmentandinstaller,forprofessionalprojectstotrackapis,references,feedsandlogins.使用思科的web服务开发工具在初始化时,我们要注意其apideer将对项目的部署做出一些封装:。这样一来,我们的apideer才能。

网页源代码抓取工具(jsoup1.4.1可以抓取,但是网页源代码抓取功能不一定很强大)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-11-30 07:09

网页源代码抓取工具一般会对关键字进行加密,多半是通过xpath来寻找,试一下jsoup抓取,可以做到爬虫并且解析页面。

你可以看一下mozilla网页源代码抓取工具jsoup,这个是谷歌开发的。

jsoup1.4.1可以抓取,但是网页源代码抓取功能不一定很强大.你可以试试pinyin工具,这个是腾讯出的,你可以试试

如果想爬小米的话可以使用小米网站收集站抓取工具,如果要抓imsg,建议加载user-agent头信息。

首先,爬虫就不是网页,所以我觉得最好的方法就是请求网页源代码进行抓取,而且网页源代码抓取工具都会对关键字进行加密,所以,爬虫需要一定的技术门槛和工具。如果你可以掌握python这门语言的话,推荐尝试一下python抓取js,以及python爬虫页面设置抓取极速模式(注意是抓取页面,不是去重,如果那样会很慢)。

爬虫可以试试jsoup,支持tcphttp,理论是完全抓取txt版,python抓取html信息的话可以使用openxml里面的定时程序(推荐)。

大家都说了我也不多说。我说一个我自己写的爬虫来回答一下。

一、用浏览器爬:bing、google、百度都可以。

二、用webdriver,selenium等。

三、不要在ie内置浏览器下安装,否则会出很多错。我这个是跑在chrome的浏览器下做的数据抓取的例子。把user-agent也加入就行。然后在浏览器上先进行抓取,出错了,再去google或百度寻找答案。 查看全部

网页源代码抓取工具(jsoup1.4.1可以抓取,但是网页源代码抓取功能不一定很强大)

网页源代码抓取工具一般会对关键字进行加密,多半是通过xpath来寻找,试一下jsoup抓取,可以做到爬虫并且解析页面。

你可以看一下mozilla网页源代码抓取工具jsoup,这个是谷歌开发的。

jsoup1.4.1可以抓取,但是网页源代码抓取功能不一定很强大.你可以试试pinyin工具,这个是腾讯出的,你可以试试

如果想爬小米的话可以使用小米网站收集站抓取工具,如果要抓imsg,建议加载user-agent头信息。

首先,爬虫就不是网页,所以我觉得最好的方法就是请求网页源代码进行抓取,而且网页源代码抓取工具都会对关键字进行加密,所以,爬虫需要一定的技术门槛和工具。如果你可以掌握python这门语言的话,推荐尝试一下python抓取js,以及python爬虫页面设置抓取极速模式(注意是抓取页面,不是去重,如果那样会很慢)。

爬虫可以试试jsoup,支持tcphttp,理论是完全抓取txt版,python抓取html信息的话可以使用openxml里面的定时程序(推荐)。

大家都说了我也不多说。我说一个我自己写的爬虫来回答一下。

一、用浏览器爬:bing、google、百度都可以。

二、用webdriver,selenium等。

三、不要在ie内置浏览器下安装,否则会出很多错。我这个是跑在chrome的浏览器下做的数据抓取的例子。把user-agent也加入就行。然后在浏览器上先进行抓取,出错了,再去google或百度寻找答案。

网页源代码抓取工具(网页源代码抓取工具、批量抓取比较常用的scrapy.exceptionsimportcrawlerandasaspd)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2021-11-29 05:01

网页源代码抓取工具、批量抓取比较常用的scrapy。比如scrapy的fromscrapy.exceptionsimportcrawler,downloader,callbackfromscrapy.exceptionsimportdownloaderimportpandasaspd#一.工作原理:1.通过最基本的输入url,从根源上找到想抓取的内容。

2.通过传入不同参数实现不同功能:初始化抓取的scrapy文件夹:download/#downloader=downloader.execute(url)3.通过利用binding接口实现对python对象的简单操作。4.根据抓取的结果进行后处理,保存返回。5.通过dict/tuple进行数据分析、反查、插入等一系列操作,最终完成返回,调用封装好的scrapyrequest对象实现后处理。

二.参考实例1.kiwokhefubevirtualmachinetogetselfpythonlibrary-kiwokhefube.github.io.io/#all。

一、用node.js+dataquest实现。(node.js简单好用,代码优雅,代码解释专业;dataquest便捷易用,代码结构混乱,容易重复实现代码。两者结合最佳。)#!/usr/bin/envpython#-*-coding:utf-8-*-#@author:黄韬#@file:python/library/cgidev.py#@file:spider_gen.pyclassdownloader(object):def__init__(self,request):self.full(request)self.execute(['location'])检查nginx是否处于关闭状态open_flash:打开打印文件名。

self.execute('location')处理请求。deffetch(self,request):根据request的内容来抓取内容。如果request为空,则直接抓取[location=='/']withself.execute(request)asself:try:self.run(downloader(request))self.add(downloader(self.full(request)))添加部分抓取。

returnself.execute('location')跳转到定义好的url上抓取self.add(downloader(self.full(request)))except:参数异常,抛出异常defupdate(self,request):self.execute('location')returnself.execute('location')deffetch_path(self,request):self.download(request)deffetch_execution(self,request):中转多少个python变量,如果不需要中转,那么变量赋值request为0,则不存在中转对象defget_title(self,request):returndefget_headers(self,request):self.download(request)if__name__。 查看全部

网页源代码抓取工具(网页源代码抓取工具、批量抓取比较常用的scrapy.exceptionsimportcrawlerandasaspd)

网页源代码抓取工具、批量抓取比较常用的scrapy。比如scrapy的fromscrapy.exceptionsimportcrawler,downloader,callbackfromscrapy.exceptionsimportdownloaderimportpandasaspd#一.工作原理:1.通过最基本的输入url,从根源上找到想抓取的内容。

2.通过传入不同参数实现不同功能:初始化抓取的scrapy文件夹:download/#downloader=downloader.execute(url)3.通过利用binding接口实现对python对象的简单操作。4.根据抓取的结果进行后处理,保存返回。5.通过dict/tuple进行数据分析、反查、插入等一系列操作,最终完成返回,调用封装好的scrapyrequest对象实现后处理。

二.参考实例1.kiwokhefubevirtualmachinetogetselfpythonlibrary-kiwokhefube.github.io.io/#all。

一、用node.js+dataquest实现。(node.js简单好用,代码优雅,代码解释专业;dataquest便捷易用,代码结构混乱,容易重复实现代码。两者结合最佳。)#!/usr/bin/envpython#-*-coding:utf-8-*-#@author:黄韬#@file:python/library/cgidev.py#@file:spider_gen.pyclassdownloader(object):def__init__(self,request):self.full(request)self.execute(['location'])检查nginx是否处于关闭状态open_flash:打开打印文件名。

self.execute('location')处理请求。deffetch(self,request):根据request的内容来抓取内容。如果request为空,则直接抓取[location=='/']withself.execute(request)asself:try:self.run(downloader(request))self.add(downloader(self.full(request)))添加部分抓取。

returnself.execute('location')跳转到定义好的url上抓取self.add(downloader(self.full(request)))except:参数异常,抛出异常defupdate(self,request):self.execute('location')returnself.execute('location')deffetch_path(self,request):self.download(request)deffetch_execution(self,request):中转多少个python变量,如果不需要中转,那么变量赋值request为0,则不存在中转对象defget_title(self,request):returndefget_headers(self,request):self.download(request)if__name__。

网页源代码抓取工具(来自《Python项目案例开发从入门到实战》(清华大学出版社郑秋生夏敏捷主编) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-11-28 04:32

)

来自《Python项目案例开发从入门到实战》(清华大学出版社郑秋生、夏敏毅主编)爬虫应用-抓取百度图片

本文使用请求库爬取了一张网站的图片。博文前几章介绍了如何使用urllib库抓取网页。本文主要使用请求库抓取网页内容和使用方法基本相同,只是请求方法比较简单

别忘了爬虫的基本思想:

1. 指定要爬取的链接然后抓取网站源码

2.提取你想要的内容,比如你想爬取图片信息,可以选择用正则表达式过滤或者使用提取

如何标记

3.循环获取要爬取的内容列表,保存文件

这里的代码和我博客前几章(图片爬虫系列一)的区别在于:

1. requests 库用于提取网页

2. 保存图片时,后缀不总是使用png或jpg,而是图片本身的后缀名

3.保存图片时,不要使用urllib.request.urlretrieve函数,而是使用文件读写操作保存图片

具体代码如下图所示:

1 # 使用requests、bs4库下载华侨大学主页上的所有图片

2 import os 3 import requests 4 from bs4 import BeautifulSoup 5 import shutil 6 from pathlib import Path # 关于文件路径操作的库,这里主要为了得到图片后缀名

7

8

9 # 该方法传入url,返回url的html的源代码

10 def getHtmlCode(url): 11 # 伪装请求的头部来隐藏自己

12 headers = { 13 'User-Agent': 'MMozilla/5.0(Windows NT 6.1; WOW64; rv:31.0) Gecko/20100101 Firefox/31.0'

14 } 15 # 获取网页

16 r = requests.get(url, headers=headers) 17 # 指定网页解析的编码格式

18 r.encoding = 'UTF-8'

19 # 获取url页面的源代码字符串文本

20 page = r.text 21 return page 22

23

24 # 该方法传入html的源代码,通过截取其中的img标签,将图片保存到本机

25 def getImg(page, localPath): 26 # 判断文件夹是否存在,存在则删除,最后都要重新新的文件夹

27 if os.path.exists(localPath): 28 shutil.rmtree(localPath) 29 os.mkdir(localPath) 30

31 # 按照Html格式解析页面

32 soup = BeautifulSoup(page, 'html.parser') 33 # 返回的是一个包含所有img标签的列表

34 imgList = soup.find_all('img') 35 x = 0 36 # 循环url列表

37 for imgUrl in imgList: 38 try: 39 # 得到img标签中的src具体内容

40 imgUrl_src = imgUrl.get('src') 41 # 排除 src='' 的情况

42 if imgUrl_src != '': 43 print('正在下载第 %d : %s 张图片' % (x+1, imgUrl_src)) 44 # 判断图片是否是从绝对路径https开始,具体为什么这样操作可以看下图所示

45 if "https://" not in imgUrl_src: 46 m = 'https://www.hqu.edu.cn/' + imgUrl_src 47 print('正在下载: %s' % m) 48 # 获取图片

49 ir = requests.get(m) 50 else: 51 ir = requests.get(imgUrl_src) 52 # 设置Path变量,为了使用Pahtlib库中的方法提取后缀名

53 p = Path(imgUrl_src) 54 # 得到后缀,返回的是如 '.jpg'

55 p_suffix = p.suffix 56 # 用write()方法写入本地文件中,存储的后缀名用原始的后缀名称

57 open(localPath + str(x) + p_suffix, 'wb').write(ir.content) 58 x = x + 1

59 except: 60 continue

61

62

63 if __name__ == '__main__': 64 # 指定爬取图片链接

65 url = 'https://www.hqu.edu.cn/index.htm'

66 # 指定存储图片路径

67 localPath = './img/'

68 # 得到网页源代码

69 page = getHtmlCode(url) 70 # 保存图片

71 getImg(page, localPath)

注意,我们之所以判断图片链接是否以“https://”开头,主要是因为我们需要完整的绝对路径来下载图片,并且需要查看原创网页代码,选择图片,然后单击 html 所在的代码。 , 鼠标悬停,可以看到绝对路径,然后根据这个绝对路径设置需要添加的缺失部分,如下图:

查看全部

网页源代码抓取工具(来自《Python项目案例开发从入门到实战》(清华大学出版社郑秋生夏敏捷主编)

)

来自《Python项目案例开发从入门到实战》(清华大学出版社郑秋生、夏敏毅主编)爬虫应用-抓取百度图片

本文使用请求库爬取了一张网站的图片。博文前几章介绍了如何使用urllib库抓取网页。本文主要使用请求库抓取网页内容和使用方法基本相同,只是请求方法比较简单

别忘了爬虫的基本思想:

1. 指定要爬取的链接然后抓取网站源码

2.提取你想要的内容,比如你想爬取图片信息,可以选择用正则表达式过滤或者使用提取

如何标记

3.循环获取要爬取的内容列表,保存文件

这里的代码和我博客前几章(图片爬虫系列一)的区别在于:

1. requests 库用于提取网页

2. 保存图片时,后缀不总是使用png或jpg,而是图片本身的后缀名

3.保存图片时,不要使用urllib.request.urlretrieve函数,而是使用文件读写操作保存图片

具体代码如下图所示:

1 # 使用requests、bs4库下载华侨大学主页上的所有图片

2 import os 3 import requests 4 from bs4 import BeautifulSoup 5 import shutil 6 from pathlib import Path # 关于文件路径操作的库,这里主要为了得到图片后缀名

7

8

9 # 该方法传入url,返回url的html的源代码

10 def getHtmlCode(url): 11 # 伪装请求的头部来隐藏自己

12 headers = { 13 'User-Agent': 'MMozilla/5.0(Windows NT 6.1; WOW64; rv:31.0) Gecko/20100101 Firefox/31.0'

14 } 15 # 获取网页

16 r = requests.get(url, headers=headers) 17 # 指定网页解析的编码格式

18 r.encoding = 'UTF-8'

19 # 获取url页面的源代码字符串文本

20 page = r.text 21 return page 22

23

24 # 该方法传入html的源代码,通过截取其中的img标签,将图片保存到本机

25 def getImg(page, localPath): 26 # 判断文件夹是否存在,存在则删除,最后都要重新新的文件夹

27 if os.path.exists(localPath): 28 shutil.rmtree(localPath) 29 os.mkdir(localPath) 30

31 # 按照Html格式解析页面

32 soup = BeautifulSoup(page, 'html.parser') 33 # 返回的是一个包含所有img标签的列表

34 imgList = soup.find_all('img') 35 x = 0 36 # 循环url列表

37 for imgUrl in imgList: 38 try: 39 # 得到img标签中的src具体内容

40 imgUrl_src = imgUrl.get('src') 41 # 排除 src='' 的情况

42 if imgUrl_src != '': 43 print('正在下载第 %d : %s 张图片' % (x+1, imgUrl_src)) 44 # 判断图片是否是从绝对路径https开始,具体为什么这样操作可以看下图所示

45 if "https://" not in imgUrl_src: 46 m = 'https://www.hqu.edu.cn/' + imgUrl_src 47 print('正在下载: %s' % m) 48 # 获取图片

49 ir = requests.get(m) 50 else: 51 ir = requests.get(imgUrl_src) 52 # 设置Path变量,为了使用Pahtlib库中的方法提取后缀名

53 p = Path(imgUrl_src) 54 # 得到后缀,返回的是如 '.jpg'

55 p_suffix = p.suffix 56 # 用write()方法写入本地文件中,存储的后缀名用原始的后缀名称

57 open(localPath + str(x) + p_suffix, 'wb').write(ir.content) 58 x = x + 1

59 except: 60 continue

61

62

63 if __name__ == '__main__': 64 # 指定爬取图片链接

65 url = 'https://www.hqu.edu.cn/index.htm'

66 # 指定存储图片路径

67 localPath = './img/'

68 # 得到网页源代码

69 page = getHtmlCode(url) 70 # 保存图片

71 getImg(page, localPath)

注意,我们之所以判断图片链接是否以“https://”开头,主要是因为我们需要完整的绝对路径来下载图片,并且需要查看原创网页代码,选择图片,然后单击 html 所在的代码。 , 鼠标悬停,可以看到绝对路径,然后根据这个绝对路径设置需要添加的缺失部分,如下图:

网页源代码抓取工具(WebHarvy,网页采集大师汉化版会智能地识别数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 957 次浏览 • 2021-11-28 04:27

WebHarvy网页采集大师中文版是一款国外工具采集,网站的第一个中文版,这个程序已经汉化了90%,编辑受限网页的软件非常容易使用和功能强大的应用程序,可以自动从网页中提取数据(文本、URL 和图像)并将提取的内容以不同格式保存。

应用说明

WebHarvy 是一个方便的应用程序,旨在使您能够自动从网页中提取数据并将提取的内容以不同的格式保存。WebHarvy,从网页捕获数据就像导航到收录数据的页面并单击数据捕获一样简单。WebHarvy 将智能识别网页上出现的数据模式。使用WebHarvy,您可以从不同的网站中提取数据,例如产品目录或搜索结果,例如房地产、电子商务、学术研究、娱乐、技术等。网页可以保存为不同的格式。通常网页显示数据,例如多个页面上的搜索结果。WebHarvy 可以自动从多个页面抓取和提取数据。

软件特点

WebHarvy 允许您分析网页上的数据

可以显示和分析来自 HTML 地址的连接数据

可以扩展到下一个网页

可以指定搜索数据的范围和内容

您可以下载并保存扫描的图片

支持浏览器复制链接搜索

支持配置对应的资源项搜索

您可以使用项目名称和资源名称来查找

特征

可视化点击界面

WebHarvy 是一个可视化的网页提取工具。实际上,无需编写任何脚本或代码来提取数据。使用 WebHarvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。太容易了!

智能识别模式

自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

导出捕获的数据

您可以以各种格式保存从网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

从多个页面中提取

通常网页会在多个页面上显示数据,例如产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“链接到下一页”,WebHarvy网站 抓取器就会自动从所有页面抓取数据。

基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,您创建的配置将自动为所有给定的输入关键字重复。可以指定任意数量的输入关键字

由代理服务器提取

要提取匿名并防止提取网络软件被阻止的Web服务器,您必须通过{over}{filtering}选项才能访问目标网站。您可以使用单个代理服务器地址或代理服务器地址列表。

提取分类

WebHarvy网站 抓取工具允许您从链接列表中提取数据,从而在 网站 中生成一个类似的页面。这允许您使用单个配置在 网站 中抓取类别或小节。

使用正则表达式提取

WebHarvy 可以在网页的文本或 HTML 源代码中应用正则表达式(正则表达式),并提取匹配的部分。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。

外部链接搜索教程(使用 WebHarvy 建议 采集 工具) 查看全部

网页源代码抓取工具(WebHarvy,网页采集大师汉化版会智能地识别数据)

WebHarvy网页采集大师中文版是一款国外工具采集,网站的第一个中文版,这个程序已经汉化了90%,编辑受限网页的软件非常容易使用和功能强大的应用程序,可以自动从网页中提取数据(文本、URL 和图像)并将提取的内容以不同格式保存。

应用说明

WebHarvy 是一个方便的应用程序,旨在使您能够自动从网页中提取数据并将提取的内容以不同的格式保存。WebHarvy,从网页捕获数据就像导航到收录数据的页面并单击数据捕获一样简单。WebHarvy 将智能识别网页上出现的数据模式。使用WebHarvy,您可以从不同的网站中提取数据,例如产品目录或搜索结果,例如房地产、电子商务、学术研究、娱乐、技术等。网页可以保存为不同的格式。通常网页显示数据,例如多个页面上的搜索结果。WebHarvy 可以自动从多个页面抓取和提取数据。

软件特点

WebHarvy 允许您分析网页上的数据

可以显示和分析来自 HTML 地址的连接数据

可以扩展到下一个网页

可以指定搜索数据的范围和内容

您可以下载并保存扫描的图片

支持浏览器复制链接搜索

支持配置对应的资源项搜索

您可以使用项目名称和资源名称来查找

特征

可视化点击界面

WebHarvy 是一个可视化的网页提取工具。实际上,无需编写任何脚本或代码来提取数据。使用 WebHarvy 的内置浏览器浏览网页。您可以选择通过单击鼠标来提取数据。太容易了!

智能识别模式

自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需进行任何额外配置。如果数据重复,WebHarvy 会自动抓取它。

导出捕获的数据

您可以以各种格式保存从网页中提取的数据。当前版本的 WebHarvy网站 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文件。您还可以将抓取的数据导出到 SQL 数据库。

从多个页面中提取

通常网页会在多个页面上显示数据,例如产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。只需指出“链接到下一页”,WebHarvy网站 抓取器就会自动从所有页面抓取数据。

基于关键字的提取

基于关键字的提取允许您捕获从搜索结果页面输入的关键字的列表数据。在挖掘数据时,您创建的配置将自动为所有给定的输入关键字重复。可以指定任意数量的输入关键字

由代理服务器提取

要提取匿名并防止提取网络软件被阻止的Web服务器,您必须通过{over}{filtering}选项才能访问目标网站。您可以使用单个代理服务器地址或代理服务器地址列表。

提取分类

WebHarvy网站 抓取工具允许您从链接列表中提取数据,从而在 网站 中生成一个类似的页面。这允许您使用单个配置在 网站 中抓取类别或小节。

使用正则表达式提取

WebHarvy 可以在网页的文本或 HTML 源代码中应用正则表达式(正则表达式),并提取匹配的部分。这种强大的技术为您提供了更大的灵活性,同时也可以为您提供数据。

外部链接搜索教程(使用 WebHarvy 建议 采集 工具)

网页源代码抓取工具(年第期计算机系统应用网页源码抓取方法的设计与实现)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-11-25 01:01

第一期计算机系统应用源码抓取方法的设计与实现①王伟,西安财经大学信息与教育技术中心,陕西西安 摘要分析嵌入式框架的不足在实际应用中,设计并实现了一种基于正则化的抓取网页源代码的表达方法。而在环境中,方法是用语言实现的。这种方法具有页面生成简单快捷的优点,提高了网页的可读性和安全性,生成的页面也更有利于设计人员的使用。官建词网页源码中使用正则表达式捕获嵌入框架的引入时,如何去除标题,格式和引用页的列。在网页设计中,嵌入的框架经常被用来报告“垃圾”。信息页面不像传统的文本。它可以在网页中整齐干净地引用。它收录很多噪音。一般来说,取网页的内容。通过这种网页嵌入技术,设计需要被引用网站 为引用者提供“专家只需要使用简单的网页标记、网页”,以及网页的样式、栏目、布局等内容要设计的页面可以根据内容丰富、功能多样化、信息实时化等,确定这个“特殊网页”。这样的解决方案需要网页设计设计。通过这种网页嵌入技术,设计需要被引用网站 为引用者提供“专家只需要使用简单的网页标记、网页”,以及网页的样式、栏目、布局等内容要设计的页面可以根据内容丰富、功能多样化、信息实时化等,确定这个“特殊网页”。这样的解决方案需要网页设计设计。通过这种网页嵌入技术,设计需要被引用网站 为引用者提供“专家只需要使用简单的网页标记、网页”,以及网页的样式、栏目、布局等内容要设计的页面可以根据内容丰富、功能多样化、信息实时化等,确定这个“特殊网页”。这样的解决方案需要网页设计设计。

但是,带来这么多优秀的设计师显然存在很大的局限性。同时,它也有其不足之处。针对该思路的不足,采用抓取网页源代码的技术,对引用的页面进行分析。随着信息技术的飞速发展,信息安全问题不允许输出浏览器的源代码,找出需要引用的部分代码的共性和差异。目前存在大量有害信息,如木马、病毒、非篡改等。将同一部分代码转换成正则表达式常量,使用网站方法进行传播。当用户访问代码的不同部分并将它们转换为正则表达式变量时,他们无法知道当前浏览网站 使用多少正则表达式过滤文本内容,同时通过正则网站。过滤后,链接引用信息的用户内容被重新组织和输出。用这种方法,不仅可以灵活多变,判断起来也比较困难,稍不留神就会“成功”。因此,大部分网页内容都是精选的,不用担心使用有不同程度限制和多重限制的浏览器和安全软件浏览器。用户通过内部数据安全保护产品的浏览器看到的内容也禁止用户浏览。此内容是筛选后重新生成的静态页面,这也保证了样本,

也就是说,用户根本无法浏览完整的内容。另外,即使用户的浏览器、安全防护软件等允许正则表达式允许浏览,仍然有一个问题需要设计者解决。正则表达式是指一个问题,即“如何使用引用的网页?,在一个网页中合理排列描述或匹配一系列符合某种语法规则的字符串。” 这个问题也是让设计师很头疼的一个字符串。正则表达式首先出现在理论计算机科学中。例如在网页中引用某新闻网的新闻条目的自动控制理论和形式语言理论。未来的一些其他领域 ① 基金项目 国家自然科学基金 陕西省自然科学基金 其在数学方面的延伸研究。在数学中,正则集合的数学符号被用来描述这个模型。目前,正则表达式广泛用于各种系统和各种计算机程序中,用来定义要引用的网页地址设计语言。正则表达式实际上是一种生成字符串,"的字符串。

在引用的页面上使用正则表达式“定义用于存储输出结果的字符串清洗”可以非常准确地匹配网页代码的特征。”,,创建实例的实现方法是众所周知的。幸运的是,语言提供的类可以从资源发送和下载数据,并从任何本地或识别的资源返回字节数组数据,并可以从这些资源接收数据。[ 《环境语言编程,使用提供的源码转换类,实现指定网页的源码,并以",,,的格式输出,需要插入引用页面的地方,添加对应的"脚本即可可以调用。以“新闻采集异常中心”栏目为例,并给出了网页抓取和页面调用的实现方法步骤。2、分析源码,得到正则表达式。在这个例子中,除了链接地址、新闻标题和发布时间三部分之外,每条新闻都具有完全相同的代码。代码是一样的。定义变量,分别代表这三个部分。使用正则表达式处理捕获的代码。在Ding环境下新建一个应用项目,在项目下新建一个文件。部分源代码定义输出字符串代码如下。引用命名空间',,”,,”,,,, ,引用定义正则表达式变量所需的命名空间,分别表示引用正则表达式所需的命名空间链接地址,新闻标题,发布时间"" "乃,, [",, © 1994 -2009 中国学术期刊电子出版社。版权所有。计算机系统应用程序定义了满足条件的新闻格式行的循环替换。当大量数据被替换时,速度非常快。生成的,企业,“代码是基于设计者需要自由定义的风格,具有良好的灵活性”。© 1994 -2009 中国学术期刊电子出版社。版权所有。计算机系统应用程序定义了满足条件的新闻格式行的循环替换。当大量数据被替换时,速度非常快。生成的,企业,“代码是基于设计者需要自由定义的风格,具有良好的灵活性”。

计算机自动生成系统设计与实现、一、一、路虎、宋玉清等协议分析异常检测方法计算机应用及软件,北京清华大学某技术知情人在浏览器中运行,符合条件新闻标题以“张黎明、江泽君等”的格式输出为静态页面。在线升级者可以根据页面的需要自由定义输出文本的样式。

高级微电子与计算机,一、二数据服务,高级程序设计结语,毛耀飞着,清华大学出版社译。该方法替代了传统的调用方法,避免了北京清华大学出版的各种邵鹤鸣面向对象编程软件的局限性,具有很好的安全性。利用正则表达式走进社会,公司实践经验 © 1994-2009 中国学术期刊电子出版社。版权所有。 查看全部

网页源代码抓取工具(年第期计算机系统应用网页源码抓取方法的设计与实现)

第一期计算机系统应用源码抓取方法的设计与实现①王伟,西安财经大学信息与教育技术中心,陕西西安 摘要分析嵌入式框架的不足在实际应用中,设计并实现了一种基于正则化的抓取网页源代码的表达方法。而在环境中,方法是用语言实现的。这种方法具有页面生成简单快捷的优点,提高了网页的可读性和安全性,生成的页面也更有利于设计人员的使用。官建词网页源码中使用正则表达式捕获嵌入框架的引入时,如何去除标题,格式和引用页的列。在网页设计中,嵌入的框架经常被用来报告“垃圾”。信息页面不像传统的文本。它可以在网页中整齐干净地引用。它收录很多噪音。一般来说,取网页的内容。通过这种网页嵌入技术,设计需要被引用网站 为引用者提供“专家只需要使用简单的网页标记、网页”,以及网页的样式、栏目、布局等内容要设计的页面可以根据内容丰富、功能多样化、信息实时化等,确定这个“特殊网页”。这样的解决方案需要网页设计设计。通过这种网页嵌入技术,设计需要被引用网站 为引用者提供“专家只需要使用简单的网页标记、网页”,以及网页的样式、栏目、布局等内容要设计的页面可以根据内容丰富、功能多样化、信息实时化等,确定这个“特殊网页”。这样的解决方案需要网页设计设计。通过这种网页嵌入技术,设计需要被引用网站 为引用者提供“专家只需要使用简单的网页标记、网页”,以及网页的样式、栏目、布局等内容要设计的页面可以根据内容丰富、功能多样化、信息实时化等,确定这个“特殊网页”。这样的解决方案需要网页设计设计。

但是,带来这么多优秀的设计师显然存在很大的局限性。同时,它也有其不足之处。针对该思路的不足,采用抓取网页源代码的技术,对引用的页面进行分析。随着信息技术的飞速发展,信息安全问题不允许输出浏览器的源代码,找出需要引用的部分代码的共性和差异。目前存在大量有害信息,如木马、病毒、非篡改等。将同一部分代码转换成正则表达式常量,使用网站方法进行传播。当用户访问代码的不同部分并将它们转换为正则表达式变量时,他们无法知道当前浏览网站 使用多少正则表达式过滤文本内容,同时通过正则网站。过滤后,链接引用信息的用户内容被重新组织和输出。用这种方法,不仅可以灵活多变,判断起来也比较困难,稍不留神就会“成功”。因此,大部分网页内容都是精选的,不用担心使用有不同程度限制和多重限制的浏览器和安全软件浏览器。用户通过内部数据安全保护产品的浏览器看到的内容也禁止用户浏览。此内容是筛选后重新生成的静态页面,这也保证了样本,

也就是说,用户根本无法浏览完整的内容。另外,即使用户的浏览器、安全防护软件等允许正则表达式允许浏览,仍然有一个问题需要设计者解决。正则表达式是指一个问题,即“如何使用引用的网页?,在一个网页中合理排列描述或匹配一系列符合某种语法规则的字符串。” 这个问题也是让设计师很头疼的一个字符串。正则表达式首先出现在理论计算机科学中。例如在网页中引用某新闻网的新闻条目的自动控制理论和形式语言理论。未来的一些其他领域 ① 基金项目 国家自然科学基金 陕西省自然科学基金 其在数学方面的延伸研究。在数学中,正则集合的数学符号被用来描述这个模型。目前,正则表达式广泛用于各种系统和各种计算机程序中,用来定义要引用的网页地址设计语言。正则表达式实际上是一种生成字符串,"的字符串。

在引用的页面上使用正则表达式“定义用于存储输出结果的字符串清洗”可以非常准确地匹配网页代码的特征。”,,创建实例的实现方法是众所周知的。幸运的是,语言提供的类可以从资源发送和下载数据,并从任何本地或识别的资源返回字节数组数据,并可以从这些资源接收数据。[ 《环境语言编程,使用提供的源码转换类,实现指定网页的源码,并以",,,的格式输出,需要插入引用页面的地方,添加对应的"脚本即可可以调用。以“新闻采集异常中心”栏目为例,并给出了网页抓取和页面调用的实现方法步骤。2、分析源码,得到正则表达式。在这个例子中,除了链接地址、新闻标题和发布时间三部分之外,每条新闻都具有完全相同的代码。代码是一样的。定义变量,分别代表这三个部分。使用正则表达式处理捕获的代码。在Ding环境下新建一个应用项目,在项目下新建一个文件。部分源代码定义输出字符串代码如下。引用命名空间',,”,,”,,,, ,引用定义正则表达式变量所需的命名空间,分别表示引用正则表达式所需的命名空间链接地址,新闻标题,发布时间"" "乃,, [",, © 1994 -2009 中国学术期刊电子出版社。版权所有。计算机系统应用程序定义了满足条件的新闻格式行的循环替换。当大量数据被替换时,速度非常快。生成的,企业,“代码是基于设计者需要自由定义的风格,具有良好的灵活性”。© 1994 -2009 中国学术期刊电子出版社。版权所有。计算机系统应用程序定义了满足条件的新闻格式行的循环替换。当大量数据被替换时,速度非常快。生成的,企业,“代码是基于设计者需要自由定义的风格,具有良好的灵活性”。

计算机自动生成系统设计与实现、一、一、路虎、宋玉清等协议分析异常检测方法计算机应用及软件,北京清华大学某技术知情人在浏览器中运行,符合条件新闻标题以“张黎明、江泽君等”的格式输出为静态页面。在线升级者可以根据页面的需要自由定义输出文本的样式。

高级微电子与计算机,一、二数据服务,高级程序设计结语,毛耀飞着,清华大学出版社译。该方法替代了传统的调用方法,避免了北京清华大学出版的各种邵鹤鸣面向对象编程软件的局限性,具有很好的安全性。利用正则表达式走进社会,公司实践经验 © 1994-2009 中国学术期刊电子出版社。版权所有。

网页源代码抓取工具(Python中获取指定网页源码的具体代码,具体内容如下 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2021-11-24 10:13

)

本文示例分享了Python的具体代码,获取指定网页的源码,供大家参考。具体内容如下

1、任务介绍

前段时间一直在学习Python的基础知识,所以一直没有更新我的博客。最近一段时间学习了一些爬虫的知识。我会更新在多个博客中学到的知识。今天分享的是获取指定网页源代码的方法。只有抓取网页的源代码,我们才能从中提取出我们需要的数据。

2、任务代码

Python中获取指定网页源代码的方法比较简单。我用Java 38行代码获取网页源代码(可能是学术能力差),而只用了6行Python就达到了效果。

在 Python 中获取网页源代码的最简单方法是使用 urllib 包。具体代码如下:

import urllib.request #导入urllib.request库

b = str(input("请输入:")) #提示用户输入信息,并强制类型转换为字符串型

a = urllib.request.urlopen(b)#打开指定网址

html = a.read() #读取网页源码

html = html.decode("utf-8") #解码为unicode码

print(html) #打印网页源码

我输入的网址是我博客首页的网址

运行结果如下:

3、总结

本篇博客介绍的方法比较简单。事实上,有些网站会“反爬虫”。这时候就需要使用User-Agent或者代理。这些内容将在以下博客中更新。期待以后更新博客中的“阅读CSDN博客访问量小程序”和“有道翻译小程序”等较难的知识。由于刚开始学习爬虫,水平有限,请多多包涵。

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持。

查看全部

网页源代码抓取工具(Python中获取指定网页源码的具体代码,具体内容如下

)

本文示例分享了Python的具体代码,获取指定网页的源码,供大家参考。具体内容如下

1、任务介绍

前段时间一直在学习Python的基础知识,所以一直没有更新我的博客。最近一段时间学习了一些爬虫的知识。我会更新在多个博客中学到的知识。今天分享的是获取指定网页源代码的方法。只有抓取网页的源代码,我们才能从中提取出我们需要的数据。

2、任务代码

Python中获取指定网页源代码的方法比较简单。我用Java 38行代码获取网页源代码(可能是学术能力差),而只用了6行Python就达到了效果。

在 Python 中获取网页源代码的最简单方法是使用 urllib 包。具体代码如下:

import urllib.request #导入urllib.request库

b = str(input("请输入:")) #提示用户输入信息,并强制类型转换为字符串型

a = urllib.request.urlopen(b)#打开指定网址

html = a.read() #读取网页源码

html = html.decode("utf-8") #解码为unicode码

print(html) #打印网页源码

我输入的网址是我博客首页的网址

运行结果如下:

3、总结

本篇博客介绍的方法比较简单。事实上,有些网站会“反爬虫”。这时候就需要使用User-Agent或者代理。这些内容将在以下博客中更新。期待以后更新博客中的“阅读CSDN博客访问量小程序”和“有道翻译小程序”等较难的知识。由于刚开始学习爬虫,水平有限,请多多包涵。

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持。

网页源代码抓取工具( 我用Python3简单抓取网页图片实例-上海怡健医学(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-11-19 12:06

我用Python3简单抓取网页图片实例-上海怡健医学(图))

Python3简单爬虫抓取网页图片代码示例

更新时间:2019-08-26 11:52:16 作者:瀛洲国科

本文文章主要介绍Python3简单爬虫抓取网页图片代码示例。文章通过示例代码介绍了非常详细的例子。对大家的学习或工作有一定的参考学习价值。有需要的朋友可以参考。

网上有很多用python2编写的爬虫抓取网页图片的例子,但是不适合新手(新手使用python3环境,不兼容python2),

于是写了一个简单的例子,用Python3语法抓取网页图片。希望能帮到你,也希望你能批评指正。

import urllib.request

import re

import os

import urllib

#根据给定的网址来获取网页详细信息,得到的html就是网页的源代码

def getHtml(url):

page = urllib.request.urlopen(url)

html = page.read()

return html.decode('UTF-8')

def getImg(html):

reg = r'src="(.+?\.jpg)" pic_ext'

imgre = re.compile(reg)

imglist = imgre.findall(html)#表示在整个网页中过滤出所有图片的地址,放在imglist中

x = 0

path = 'D:\\test'

# 将图片保存到D:\\test文件夹中,如果没有test文件夹则创建

if not os.path.isdir(path):

os.makedirs(path)

paths = path+'\\' #保存在test路径下

for imgurl in imglist:

urllib.request.urlretrieve(imgurl,'{0}{1}.jpg'.format(paths,x)) #打开imglist中保存的图片网址,并下载图片保存在本地,format格式化字符串

x = x + 1

return imglist

html = getHtml("http://tieba.baidu.com/p/2460150866")#获取该网址网页详细信息,得到的html就是网页的源代码

print (getImg(html)) #从网页源代码中分析并下载保存图片

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持im棋牌。 查看全部

网页源代码抓取工具(

我用Python3简单抓取网页图片实例-上海怡健医学(图))

Python3简单爬虫抓取网页图片代码示例

更新时间:2019-08-26 11:52:16 作者:瀛洲国科

本文文章主要介绍Python3简单爬虫抓取网页图片代码示例。文章通过示例代码介绍了非常详细的例子。对大家的学习或工作有一定的参考学习价值。有需要的朋友可以参考。

网上有很多用python2编写的爬虫抓取网页图片的例子,但是不适合新手(新手使用python3环境,不兼容python2),

于是写了一个简单的例子,用Python3语法抓取网页图片。希望能帮到你,也希望你能批评指正。

import urllib.request

import re

import os

import urllib

#根据给定的网址来获取网页详细信息,得到的html就是网页的源代码

def getHtml(url):

page = urllib.request.urlopen(url)

html = page.read()

return html.decode('UTF-8')

def getImg(html):

reg = r'src="(.+?\.jpg)" pic_ext'

imgre = re.compile(reg)

imglist = imgre.findall(html)#表示在整个网页中过滤出所有图片的地址,放在imglist中

x = 0

path = 'D:\\test'

# 将图片保存到D:\\test文件夹中,如果没有test文件夹则创建

if not os.path.isdir(path):

os.makedirs(path)

paths = path+'\\' #保存在test路径下

for imgurl in imglist:

urllib.request.urlretrieve(imgurl,'{0}{1}.jpg'.format(paths,x)) #打开imglist中保存的图片网址,并下载图片保存在本地,format格式化字符串

x = x + 1

return imglist

html = getHtml("http://tieba.baidu.com/p/2460150866";)#获取该网址网页详细信息,得到的html就是网页的源代码

print (getImg(html)) #从网页源代码中分析并下载保存图片

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持im棋牌。

网页源代码抓取工具(如何通过Chrome开发者工具寻找一个网站上特定数据的抓取方式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-11-14 18:16

网上爬虫教程太多了。在知乎上搜索,我猜你能找到不少于100个。每个人都乐于从互联网上抢一个接一个的网站。但是只要对方网站更新,很可能文章里面的方法就失效了。

每个网站捕获的代码不同,但背后的原理是一样的。对于绝大多数网站来说,爬行套路就是这样。今天的文章不讲什么具体的网站爬取,只讲一个共同点:

如何使用 Chrome 开发者工具找到一种方法来捕获 网站 上的特定数据。

(我这里演示的是Mac上英文版的Chrome,中文版Windows的使用方法是一样的。)

> 查看网页源代码

右键点击网页,选择“查看页面源代码”,新标签页中会显示该URL对应的HTML代码文本。

此功能不被视为“开发人员工具”的一部分,但它也非常常用。此内容与您通过代码直接向此 URL 发送 GET 请求所获得的结果相同(无论是否存在权限问题)。如果你能在这个源码页上找到你想要的内容,就可以按照它的规则,通过regular、bs4、xpath等方法提取文本中的数据。

但是,对于很多异步加载数据的网站来说,你在这个页面上找不到你想要的。或者因为权限和验证的限制,在代码中得到的结果与页面显示不一致。在这些情况下,我们需要更强大的开发人员工具来提供帮助。

> 元素

在网页上右击选择“Inspect”,进入Chrome Developer Tools的元素选择器。在工具中是元素选项卡。

元素有几个功能:

从 Elements 工具中定位数据比直接在源代码中搜索更方便,因为您可以清楚地看到它所在的元素结构。但这里特别提醒:

Elements 中看到的代码不等于请求 URL 的返回值。

是浏览器渲染的网页最终效果,包括异步请求数据,以及浏览器自身对代码的优化改动。因此,您无法根据 Elements 中显示的结构获取元素。在这种情况下,您可能无法获得正确的结果。

> 网络

在开发者工具中选择Network选项卡,进入网络监控功能,也就是常说的“抓包”。

这是爬虫使用的最重要的功能。主要解决两个问题:

捕捉什么

抓住的是如何找到通过异步请求获取的数据的来源。

打开网络页面,打开记录,然后刷新页面,可以看到所有发送的请求,包括数据、JS、CSS、图片、文档等都会显示出来。您可以从请求列表中找到您的目标。

一个一个地找到它们会很痛苦。分享几个小贴士:

找到收录数据的请求后,下一步就是使用程序获取数据。这时候就是第二个问题:怎么抓。

不是所有的URL都可以通过GET直接获取(相当于在浏览器中打开地址),通常要考虑这些:

请求方法是 GET 或 POST。请求附加的参数数据。GET 和 POST 有不同的参数传递方法。标头信息。常用的有user-agent、host、referer、cookie等,其中cookie是用来识别请求者的关键信息。对于需要登录的网站来说,这个值是必不可少的。网站 经常使用其他几个项目来标识请求的合法性。相同的请求在浏览器中可用,但在程序中不可用。大多数标题信息是不正确的。您可以将此信息从 Chrome 复制到程序中以绕过对方的限制。

单击列表中的特定请求,可以找到上述所有信息。

找到正确的请求,设置正确的方法,传递正确的参数和头信息,网站上的大部分信息都可以处理。

网络还有一个功能:右键单击列表,选择“另存为带有内容的HAR”,然后保存到文件中。该文件收录列表中的所有请求参数和返回值信息,以便您查找和分析。(在实际操作中发现直接搜索往往无效,只能保存到文件后才能搜索)

除了 Elements 和 Network 之外,开发者工具中还有一些功能,例如:

Sources,查看资源列表,调试JS。

控制台,显示页面的错误和输出,可以执行JS代码。很多网站都会在这里放招聘彩蛋(找更多有名的网站试试)。

但这些功能与爬虫关系不大。如果开发网站,优化网站速度,还需要处理其他功能。这里不多说。

综上所述,其实你应该记住以下几点:

在“查看源代码”中可以看到的数据,可以通过程序直接请求当前的URL来获取。Elements 中的 HTML 代码不等于请求的返回值,只能作为辅助。使用网络中的内容关键字搜索,或将其保存为HAR文件后搜索以找到收录数据的实际请求。查看请求的具体信息,包括方法、头部和参数,并复制到程序中使用。

了解了这些步骤后,网上的资料大部分都可以得到了,说“解决了一半”不是头条党。

当然,说起来容易些。如果你想精通,还有很多细节需要考虑,你需要不断练习。但是拿这些点来看看各种爬虫案例,思路会更清晰。

如果你想要更详细的爬虫讲解和指导,可以看看我们的《爬虫实战》课程,也有零基础入门课程。

对课程详情公众号回复码的操作(Crossin的编程课堂)

====

其他 文章 和回答:

如何自学Python|新手指南||Python单词表|区块链|人工智能|双11|嘻哈|爬虫|排序算法|我用Python|高考|世界杯|猜猜|请求

欢迎搜索关注:Crossin的编程课堂 查看全部

网页源代码抓取工具(如何通过Chrome开发者工具寻找一个网站上特定数据的抓取方式)

网上爬虫教程太多了。在知乎上搜索,我猜你能找到不少于100个。每个人都乐于从互联网上抢一个接一个的网站。但是只要对方网站更新,很可能文章里面的方法就失效了。

每个网站捕获的代码不同,但背后的原理是一样的。对于绝大多数网站来说,爬行套路就是这样。今天的文章不讲什么具体的网站爬取,只讲一个共同点:

如何使用 Chrome 开发者工具找到一种方法来捕获 网站 上的特定数据。

(我这里演示的是Mac上英文版的Chrome,中文版Windows的使用方法是一样的。)

> 查看网页源代码

右键点击网页,选择“查看页面源代码”,新标签页中会显示该URL对应的HTML代码文本。

此功能不被视为“开发人员工具”的一部分,但它也非常常用。此内容与您通过代码直接向此 URL 发送 GET 请求所获得的结果相同(无论是否存在权限问题)。如果你能在这个源码页上找到你想要的内容,就可以按照它的规则,通过regular、bs4、xpath等方法提取文本中的数据。

但是,对于很多异步加载数据的网站来说,你在这个页面上找不到你想要的。或者因为权限和验证的限制,在代码中得到的结果与页面显示不一致。在这些情况下,我们需要更强大的开发人员工具来提供帮助。

> 元素

在网页上右击选择“Inspect”,进入Chrome Developer Tools的元素选择器。在工具中是元素选项卡。

元素有几个功能:

从 Elements 工具中定位数据比直接在源代码中搜索更方便,因为您可以清楚地看到它所在的元素结构。但这里特别提醒:

Elements 中看到的代码不等于请求 URL 的返回值。

是浏览器渲染的网页最终效果,包括异步请求数据,以及浏览器自身对代码的优化改动。因此,您无法根据 Elements 中显示的结构获取元素。在这种情况下,您可能无法获得正确的结果。

> 网络

在开发者工具中选择Network选项卡,进入网络监控功能,也就是常说的“抓包”。

这是爬虫使用的最重要的功能。主要解决两个问题:

捕捉什么

抓住的是如何找到通过异步请求获取的数据的来源。

打开网络页面,打开记录,然后刷新页面,可以看到所有发送的请求,包括数据、JS、CSS、图片、文档等都会显示出来。您可以从请求列表中找到您的目标。

一个一个地找到它们会很痛苦。分享几个小贴士:

找到收录数据的请求后,下一步就是使用程序获取数据。这时候就是第二个问题:怎么抓。

不是所有的URL都可以通过GET直接获取(相当于在浏览器中打开地址),通常要考虑这些:

请求方法是 GET 或 POST。请求附加的参数数据。GET 和 POST 有不同的参数传递方法。标头信息。常用的有user-agent、host、referer、cookie等,其中cookie是用来识别请求者的关键信息。对于需要登录的网站来说,这个值是必不可少的。网站 经常使用其他几个项目来标识请求的合法性。相同的请求在浏览器中可用,但在程序中不可用。大多数标题信息是不正确的。您可以将此信息从 Chrome 复制到程序中以绕过对方的限制。

单击列表中的特定请求,可以找到上述所有信息。

找到正确的请求,设置正确的方法,传递正确的参数和头信息,网站上的大部分信息都可以处理。

网络还有一个功能:右键单击列表,选择“另存为带有内容的HAR”,然后保存到文件中。该文件收录列表中的所有请求参数和返回值信息,以便您查找和分析。(在实际操作中发现直接搜索往往无效,只能保存到文件后才能搜索)

除了 Elements 和 Network 之外,开发者工具中还有一些功能,例如:

Sources,查看资源列表,调试JS。

控制台,显示页面的错误和输出,可以执行JS代码。很多网站都会在这里放招聘彩蛋(找更多有名的网站试试)。

但这些功能与爬虫关系不大。如果开发网站,优化网站速度,还需要处理其他功能。这里不多说。

综上所述,其实你应该记住以下几点:

在“查看源代码”中可以看到的数据,可以通过程序直接请求当前的URL来获取。Elements 中的 HTML 代码不等于请求的返回值,只能作为辅助。使用网络中的内容关键字搜索,或将其保存为HAR文件后搜索以找到收录数据的实际请求。查看请求的具体信息,包括方法、头部和参数,并复制到程序中使用。

了解了这些步骤后,网上的资料大部分都可以得到了,说“解决了一半”不是头条党。

当然,说起来容易些。如果你想精通,还有很多细节需要考虑,你需要不断练习。但是拿这些点来看看各种爬虫案例,思路会更清晰。

如果你想要更详细的爬虫讲解和指导,可以看看我们的《爬虫实战》课程,也有零基础入门课程。

对课程详情公众号回复码的操作(Crossin的编程课堂)

====

其他 文章 和回答:

如何自学Python|新手指南||Python单词表|区块链|人工智能|双11|嘻哈|爬虫|排序算法|我用Python|高考|世界杯|猜猜|请求

欢迎搜索关注:Crossin的编程课堂

网页源代码抓取工具(获取网站源码工具,用这些工具扒网站很好处理)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-11-11 21:00

做网站的朋友经常遇到别人好看的网页,想把它们保存在本地供自己使用,但是用旧的方法把网页保存在另一个地方,发现很糟糕,规则不好办,路径不好办。. 92建站介绍了三种获取网站源码的工具,使用这些工具处理网站很容易。只需输入您要剥离的 网站。

做网站的朋友经常遇到别人好看的网页,想把它们保存在本地供自己使用,但是用旧的方法把网页保存在另一个地方,发现很糟糕,规则不好办,路径不好办。. 92建站介绍了三种获取网站源码的工具,使用这些工具处理网站很容易。只需输入您要剥离的 网站。

1、网站模板削皮器2.6绿色版

网站Template Peeler 是一款网站模板下载工具。对于网站的新手站长来说,是一款非常好用的软件。网站 Template Peeler only 你需要输入你要申请的网站的站点名称,你可以得到网站的站点代码,这样你就可以修改它,使你的自己的 网站。

本软件推荐使用服务器测试网站,下载的网站目录结构清晰,下载效果更佳!试用效果后评价!该程序将永远免费,并始终更新最完整的版本!网站的内容下载有js、CSS、CSS文件内部图片、src图片、背景图片、表框图片、深度目录!

2、单页模板扒手V4.6.1绿色版

单页模板扒手V4.6.1(仿站小工具)是一款简单易用的全站下载软件。该软件可以帮助用户下载和下载整个网页的内容。用户只需要输入网址,软件就可以将网页的相关CSS、JS、图片资源下载到本地,并对链接结构进行处理,实现网页在本地的打开和浏览。.

软件功能:1)下载单个网页的相关CSS、JS、图片等。2) 按照原路径下载。3) 按文件类型下载。4)登录后可以下载需要显示的网页。

3、仿站widget v9.0

仿网站小工具是通过网址下载静态网页的工具。从输入的URL中下载html代码,提取JS、Css、Image、Picture、Flash等静态文件URL,然后从下载的Css代码中提取Image静态文件URL,通过URL下载静态文件,并设置它根据软件保存规则,自动修改html和css代码链接路径,最后将这些静态文件按类别保存到电脑文件夹中。

下载的网页会以URL为目录,里面收录了所有的图片、JS、CSS等网页代码数据,链接路径会自动修改。是不是很方便?比如这个无忧在线文章排版工具就是我的。

以上就是获取网站的源码工具的介绍。有什么问题可以找小编进一步讨论交流~ 查看全部

网页源代码抓取工具(获取网站源码工具,用这些工具扒网站很好处理)

做网站的朋友经常遇到别人好看的网页,想把它们保存在本地供自己使用,但是用旧的方法把网页保存在另一个地方,发现很糟糕,规则不好办,路径不好办。. 92建站介绍了三种获取网站源码的工具,使用这些工具处理网站很容易。只需输入您要剥离的 网站。

做网站的朋友经常遇到别人好看的网页,想把它们保存在本地供自己使用,但是用旧的方法把网页保存在另一个地方,发现很糟糕,规则不好办,路径不好办。. 92建站介绍了三种获取网站源码的工具,使用这些工具处理网站很容易。只需输入您要剥离的 网站。

1、网站模板削皮器2.6绿色版

网站Template Peeler 是一款网站模板下载工具。对于网站的新手站长来说,是一款非常好用的软件。网站 Template Peeler only 你需要输入你要申请的网站的站点名称,你可以得到网站的站点代码,这样你就可以修改它,使你的自己的 网站。

本软件推荐使用服务器测试网站,下载的网站目录结构清晰,下载效果更佳!试用效果后评价!该程序将永远免费,并始终更新最完整的版本!网站的内容下载有js、CSS、CSS文件内部图片、src图片、背景图片、表框图片、深度目录!

2、单页模板扒手V4.6.1绿色版

单页模板扒手V4.6.1(仿站小工具)是一款简单易用的全站下载软件。该软件可以帮助用户下载和下载整个网页的内容。用户只需要输入网址,软件就可以将网页的相关CSS、JS、图片资源下载到本地,并对链接结构进行处理,实现网页在本地的打开和浏览。.

软件功能:1)下载单个网页的相关CSS、JS、图片等。2) 按照原路径下载。3) 按文件类型下载。4)登录后可以下载需要显示的网页。

3、仿站widget v9.0

仿网站小工具是通过网址下载静态网页的工具。从输入的URL中下载html代码,提取JS、Css、Image、Picture、Flash等静态文件URL,然后从下载的Css代码中提取Image静态文件URL,通过URL下载静态文件,并设置它根据软件保存规则,自动修改html和css代码链接路径,最后将这些静态文件按类别保存到电脑文件夹中。

下载的网页会以URL为目录,里面收录了所有的图片、JS、CSS等网页代码数据,链接路径会自动修改。是不是很方便?比如这个无忧在线文章排版工具就是我的。

以上就是获取网站的源码工具的介绍。有什么问题可以找小编进一步讨论交流~

网页源代码抓取工具(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 30 次浏览 • 2021-12-14 19:20

捕获网页源代码的三种实现方法

更新时间:2013年6月5日11:14:45投稿:尚科

抓取网页源代码的三种实现方法,需要的朋友可以参考

方法1比较和建议

///

/// 用HttpWebRequest取得网页源码

/// 对于带BOM的网页很有效,不管是什么编码都能正确识别

///

/// 网页地址"

/// 返回网页源文件

public static string GetHtmlSource2(string url)

{

//处理内容

string html = "";

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.Accept = "*/*"; //接受任意文件

request.UserAgent = "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.1.4322)"; // 模拟使用IE在浏览 http://www.52mvc.com

request.AllowAutoRedirect = true;//是否允许302

//request.CookieContainer = new CookieContainer();//cookie容器,

request.Referer = url; //当前页面的引用

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, Encoding.Default);

html = reader.ReadToEnd();

stream.Close();

return html;

}

方法2

using System;

using System.Collections.Generic;

using System.Linq;

using System.Web;

using System.IO;

using System.Text;

using System.Net;

namespace MySql

{

public class GetHttpData

{

public static string GetHttpData2(string Url)

{

string sException = null;

string sRslt = null;

WebResponse oWebRps = null;

WebRequest oWebRqst = WebRequest.Create(Url);

oWebRqst.Timeout = 50000;

try

{

oWebRps = oWebRqst.GetResponse();

}

catch (WebException e)

{

sException = e.Message.ToString();

}

catch (Exception e)

{

sException = e.ToString();

}

finally

{

if (oWebRps != null)

{

StreamReader oStreamRd = new StreamReader(oWebRps.GetResponseStream(), Encoding.GetEncoding("utf-8"));

sRslt = oStreamRd.ReadToEnd();

oStreamRd.Close();

oWebRps.Close();

}

}

return sRslt;

}

}

}

方法3

<p>

public static string getHtml(string url, params string [] charSets)//url是要访问的网站地址,charSet是目标网页的编码,如果传入的是null或者"",那就自动分析网页的编码

{

try

{

string charSet = null;

if (charSets.Length == 1) {

charSet = charSets[0];

}

WebClient myWebClient = new WebClient(); //创建WebClient实例myWebClient

// 需要注意的:

//有的网页可能下不下来,有种种原因比如需要cookie,编码问题等等

//这是就要具体问题具体分析比如在头部加入cookie

// webclient.Headers.Add("Cookie", cookie);

//这样可能需要一些重载方法。根据需要写就可以了

//获取或设置用于对向 Internet 资源的请求进行身份验证的网络凭据。

myWebClient.Credentials = CredentialCache.DefaultCredentials;

//如果服务器要验证用户名,密码

//NetworkCredential mycred = new NetworkCredential(struser, strpassword);

//myWebClient.Credentials = mycred;

//从资源下载数据并返回字节数组。(加@是因为网址中间有"/"符号)

byte[] myDataBuffer = myWebClient.DownloadData(url);

string strWebData = Encoding.Default.GetString(myDataBuffer);

//获取网页字符编码描述信息

Match charSetMatch = Regex.Match(strWebData, " 查看全部

网页源代码抓取工具(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

捕获网页源代码的三种实现方法

更新时间:2013年6月5日11:14:45投稿:尚科

抓取网页源代码的三种实现方法,需要的朋友可以参考

方法1比较和建议

///

/// 用HttpWebRequest取得网页源码

/// 对于带BOM的网页很有效,不管是什么编码都能正确识别

///

/// 网页地址"

/// 返回网页源文件

public static string GetHtmlSource2(string url)

{

//处理内容

string html = "";

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.Accept = "*/*"; //接受任意文件

request.UserAgent = "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.1.4322)"; // 模拟使用IE在浏览 http://www.52mvc.com

request.AllowAutoRedirect = true;//是否允许302

//request.CookieContainer = new CookieContainer();//cookie容器,

request.Referer = url; //当前页面的引用

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, Encoding.Default);

html = reader.ReadToEnd();

stream.Close();

return html;

}

方法2

using System;

using System.Collections.Generic;

using System.Linq;

using System.Web;

using System.IO;

using System.Text;

using System.Net;

namespace MySql

{

public class GetHttpData

{

public static string GetHttpData2(string Url)

{

string sException = null;

string sRslt = null;

WebResponse oWebRps = null;

WebRequest oWebRqst = WebRequest.Create(Url);

oWebRqst.Timeout = 50000;

try

{

oWebRps = oWebRqst.GetResponse();

}

catch (WebException e)

{

sException = e.Message.ToString();

}

catch (Exception e)

{

sException = e.ToString();

}

finally

{

if (oWebRps != null)

{

StreamReader oStreamRd = new StreamReader(oWebRps.GetResponseStream(), Encoding.GetEncoding("utf-8"));

sRslt = oStreamRd.ReadToEnd();

oStreamRd.Close();

oWebRps.Close();

}

}

return sRslt;

}

}

}

方法3

<p>

public static string getHtml(string url, params string [] charSets)//url是要访问的网站地址,charSet是目标网页的编码,如果传入的是null或者"",那就自动分析网页的编码

{

try

{

string charSet = null;

if (charSets.Length == 1) {

charSet = charSets[0];

}

WebClient myWebClient = new WebClient(); //创建WebClient实例myWebClient

// 需要注意的:

//有的网页可能下不下来,有种种原因比如需要cookie,编码问题等等

//这是就要具体问题具体分析比如在头部加入cookie

// webclient.Headers.Add("Cookie", cookie);

//这样可能需要一些重载方法。根据需要写就可以了

//获取或设置用于对向 Internet 资源的请求进行身份验证的网络凭据。

myWebClient.Credentials = CredentialCache.DefaultCredentials;

//如果服务器要验证用户名,密码

//NetworkCredential mycred = new NetworkCredential(struser, strpassword);

//myWebClient.Credentials = mycred;

//从资源下载数据并返回字节数组。(加@是因为网址中间有"/"符号)

byte[] myDataBuffer = myWebClient.DownloadData(url);

string strWebData = Encoding.Default.GetString(myDataBuffer);

//获取网页字符编码描述信息

Match charSetMatch = Regex.Match(strWebData, "

网页源代码抓取工具(为了简单方便,这里使用WebBrowser来玩一把,我们要注意 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-12-14 11:11

)

为了简单方便,这里我们使用WebBrowser来玩,使用WebBrowser时要注意以下几点:

第一:因为WebBrowser是System.Windows.Forms中的winform控件,所以需要设置STAThread标签。

第二:Winform是事件驱动的,Console不响应事件,所有事件都在windows消息队列中等待执行,为了防止程序假死,

我们需要调用DoEvents方法来转移控制权,让操作系统执行其他事件。

第三:WebBrowser中的内容,我们需要使用DomDocument查看,而不是DocumentText。

当时考虑过直接通过XLINQ转换成XML,读取XML数据,但是觉得这样做风险很大。如果页面代码不规范,很容易转换成XML,会例外

所以考虑直接用一个整体来保存;

然后通过 htppHandler URL 重定向。好的

/要抓取数据的页面路径

string url = "https://www.sywebsoft.com/";

//将页面上的数据转换为HTML

string html = Method.GetHtmlData(url);

// txt_content.Text = html;

//找到需要的数据匹配正则 (?.+?)

string regex = @"(?.+?)";

Regex listRegex = new Regex(regex, RegexOptions.Multiline | RegexOptions.IgnoreCase);

//得到匹配的数据集合

MatchCollection mc = listRegex.Matches(html);

JCheng.Model.School Model = new JCheng.Model.School();

//将得到的字符串分割存进数组

string[] str = txt_content.Text.Substring(0, txt_content.Text.Length - 1).Replace("<br />", "").Split(,);

//数据每六个为一个model类 ,如下循环添加入库。

for (int i = 0; i < str.Length - 1; )

{

Model.sName = str[i];

Model.sAddress = str[i + 1];

Model.sPostCode = str[i + 2];

Model.sPhone = str[i + 3];

Model.sEmail = str[i + 4];

Model.sClass = str[i + 5];

new JCheng.BLL.School().Add(Model);

i += 6;

} 查看全部

网页源代码抓取工具(为了简单方便,这里使用WebBrowser来玩一把,我们要注意

)

为了简单方便,这里我们使用WebBrowser来玩,使用WebBrowser时要注意以下几点:

第一:因为WebBrowser是System.Windows.Forms中的winform控件,所以需要设置STAThread标签。

第二:Winform是事件驱动的,Console不响应事件,所有事件都在windows消息队列中等待执行,为了防止程序假死,

我们需要调用DoEvents方法来转移控制权,让操作系统执行其他事件。

第三:WebBrowser中的内容,我们需要使用DomDocument查看,而不是DocumentText。

当时考虑过直接通过XLINQ转换成XML,读取XML数据,但是觉得这样做风险很大。如果页面代码不规范,很容易转换成XML,会例外

所以考虑直接用一个整体来保存;

然后通过 htppHandler URL 重定向。好的

/要抓取数据的页面路径

string url = "https://www.sywebsoft.com/";

//将页面上的数据转换为HTML

string html = Method.GetHtmlData(url);

// txt_content.Text = html;

//找到需要的数据匹配正则 (?.+?)

string regex = @"(?.+?)";

Regex listRegex = new Regex(regex, RegexOptions.Multiline | RegexOptions.IgnoreCase);

//得到匹配的数据集合

MatchCollection mc = listRegex.Matches(html);

JCheng.Model.School Model = new JCheng.Model.School();

//将得到的字符串分割存进数组

string[] str = txt_content.Text.Substring(0, txt_content.Text.Length - 1).Replace("<br />", "").Split(,);

//数据每六个为一个model类 ,如下循环添加入库。

for (int i = 0; i < str.Length - 1; )

{

Model.sName = str[i];

Model.sAddress = str[i + 1];

Model.sPostCode = str[i + 2];

Model.sPhone = str[i + 3];

Model.sEmail = str[i + 4];

Model.sClass = str[i + 5];

new JCheng.BLL.School().Add(Model);

i += 6;

}

网页源代码抓取工具(网页源代码抓取工具,适合新手使用的软件!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2021-12-11 16:03

网页源代码抓取工具用来抓取网页时,最常用的工具莫过于爬虫软件,不仅能解析代码,抓取到网页内容,还能清晰地展示出来,以方便你后期的针对性分析。如果你用过be工具包的网页抓取,那这款网页抓取软件你一定用过,准确来说,它是如今最简单的网页抓取软件。方便快捷且功能强大,适合新手使用。

1、打开源代码抓取软件,

2、软件获取网页地址之后,

3、复制,提取网页内容,

4、高亮出关键词,点击识别关键词,

5、添加表单,

6、选择性获取内容如果你已经尝试过这款工具,建议你尽快使用,毕竟软件还是有很多地方可以提升功能的,希望你可以快乐地使用这款工具!下面这款工具是抓取自媒体平台的,设置更复杂一些:建议新手使用;没有用过以下工具也没有关系,等你通过实战学会了方法之后再回来这里看看,也许你会重新爱上这款工具!这款工具的名字叫干货传送门,对,就是那个不管干什么事,只要按照步骤做了,都会立马进入到目标页面!如果你没有这款工具的话,那就自己去搜索吧!那么点赞转发一下吧!你点赞了吗?!如果你觉得文章写得还不错,请你点个赞鼓励一下我!谢谢你们!如果你还有其他好工具,请在下方留言区留言,或者分享给你身边的人!谢谢你们!如果你想要实战学习抓取信息,可以从自媒体运营实战开始!大牛古今自媒体运营培训,15天让你成为一个自媒体运营高手,学会运营自媒体,成就自己的事业。 查看全部

网页源代码抓取工具(网页源代码抓取工具,适合新手使用的软件!)

网页源代码抓取工具用来抓取网页时,最常用的工具莫过于爬虫软件,不仅能解析代码,抓取到网页内容,还能清晰地展示出来,以方便你后期的针对性分析。如果你用过be工具包的网页抓取,那这款网页抓取软件你一定用过,准确来说,它是如今最简单的网页抓取软件。方便快捷且功能强大,适合新手使用。

1、打开源代码抓取软件,

2、软件获取网页地址之后,

3、复制,提取网页内容,

4、高亮出关键词,点击识别关键词,

5、添加表单,

6、选择性获取内容如果你已经尝试过这款工具,建议你尽快使用,毕竟软件还是有很多地方可以提升功能的,希望你可以快乐地使用这款工具!下面这款工具是抓取自媒体平台的,设置更复杂一些:建议新手使用;没有用过以下工具也没有关系,等你通过实战学会了方法之后再回来这里看看,也许你会重新爱上这款工具!这款工具的名字叫干货传送门,对,就是那个不管干什么事,只要按照步骤做了,都会立马进入到目标页面!如果你没有这款工具的话,那就自己去搜索吧!那么点赞转发一下吧!你点赞了吗?!如果你觉得文章写得还不错,请你点个赞鼓励一下我!谢谢你们!如果你还有其他好工具,请在下方留言区留言,或者分享给你身边的人!谢谢你们!如果你想要实战学习抓取信息,可以从自媒体运营实战开始!大牛古今自媒体运营培训,15天让你成为一个自媒体运营高手,学会运营自媒体,成就自己的事业。

网页源代码抓取工具(浏览器输入一个URL站点后看到网站页面内容(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-12-09 00:13

我们在浏览器中输入一个URL站点,按回车,就可以正常在浏览器中看到网站页面的内容了。其实这个过程就是浏览器向所在的服务器发送请求,告诉服务器请求什么。服务器收到请求后,对请求进行处理和解析。如果请求的处理和解析正常,则返回给浏览器。的回应。响应中收录页面的源代码等内容,浏览器解析响应中的源代码,最终显示解析出的网页。大致流程是:浏览器请求“服务器处理分析”服务器响应并传递给浏览器“浏览器分析渲染网页”。

让我们通过实际的网络站点来了解HTTP请求和响应的过程,以及在这个过程中发生了什么样的网络请求。以Chrome浏览器访问百度网站为例。

打开Chrome浏览器,在鼠标右键菜单中选择【检查】或直接快捷键【F12】打开开发者工具,切换到【网络】。在浏览器中输入百度站点:按回车键查看发生的网络请求。如下所示:

第一个网络请求:是浏览器向百度服务器发送的访问百度站点的请求。单击此请求可查看请求的详细信息和内容。

首先是General部分,描述了请求的URL、请求方法、响应状态码以及远程服务器的地址和端口;

下面有Response Headers和Request Headers,分别是响应头和请求头。收录响应和请求的部分相关信息和内容。我们来看看这个请求的具体内容和对应的响应。

请求的组成

请求由客户端即浏览器发送到服务器。发送的请求有4个方面:请求方法、请求URL、请求头、请求正文

1.请求方法

常见的请求有 get、post、put... 类型。get类型接口一般是指获取信息的接口,比如列表查询的功能。点击查询按钮调用获取接口,然后返回信息。这意味着从服务器(后端)拉取内容。post类型一般是提交表单的功能,比如注册、导入数据等,就是post接口。这意味着将内容推送到服务器(后端)。

2.请求的站点

请求的网站是浏览器输入的URL URL

3.请求头

请求头用于指示服务器使用的附件信息,即HTTP协议规定的附加内容,必须按照协议规则进行处理。访问百度网站的请求头信息如下:

查看请求头信息相关字段的描述

Accept:请求头域,用于指定客户端可以接受什么类型的信息,如上图所示,可以接受text/html等类型的信息

Accept-Encoding 和 Accept-Language:指定客户端可接受的编码和语言

连接:连接状态

Cookie:存储的Cookie信息,主要用于维护当前会话

Host:需要访问的站点地址

User-Agent:用于向服务器标识客户端使用的操作系统、浏览器版本等信息

4.请求正文

请求体一般是携带POST类型请求的表单数据,GET类型请求体为空

响应的组成

响应服务器返回给浏览器的信息,响应的内容有三个方面:响应状态码、响应头和响应体

1.响应状态码

响应状态码表示服务器对请求信息的处理结果,如200表示响应正常,404表示未找到页面,500表示服务器出错等。

2. 响应头

响应头收录服务器对请求的响应信息,如下图所示:

查看响应头中关键字段的描述

Content-Type:文档类型,指定返回的文档是什么,例如text/html表示返回的文档是HTML文档

服务器:服务器信息,如服务器名称、版本等。

Set-Cookie:设置 Cookie

Expires:指定响应的过期时间

3.响应体

是网页的HTML源代码,点击【预览】选项卡可以查看网页的源代码

2.3、 网页组成

现代网页总是给我们呈现丰富多彩的视觉体验。不同的网页往往有很多不同的外观,搭配合理的布局、丰富的图片、动画效果等,那么这些页面是如何形成的呢?构成网页的三个主要部分:HTML、CSS 和 JavaScript。HTML构成了网页的基本结构,CSS决定了网页的布局风格,JavaScript决定了网页的可塑性和动态呈现。下面我们来详细了解一下这三个部分:

1.HTML

HTML:全称是Hyper Text Markup Language,即超文本标记语言。网页上的文字、段落、图片、按钮等元素都是由HTML定义的。比如img标签代表图片,p标签代表段落等等,在Chrome浏览器中打开百度站,鼠标右键选择【勾选】或者直接【F12】打开开发者工具就可以了在【元素】选项栏中可以看到网页的HTML源代码,如下图:

您可以查看网页的 HTML 源代码。每个标签对定义一个节点和节点属性,它们形成一个 HTML 树。这些节点标签对显示在 HTML 树中,它们具有一定的层次关系,通常由父节点、子节点和同一级别的节点表示。HTML学习可以参考W3School网站学习:

2.CSS

CSS:全称Cascading Style Sheets,即Cascading Style Sheets。CSS 用于确定网页布局样式的标准,指定网页中文本的大小、颜色、位置等属性。找到下图按钮【点击百度】查看样式:

CSS样式决定了按钮的宽高,即宽高的像素大小,还有文字颜色颜色:白色等信息,按钮背景颜色:背景色

3.JavaScript