文章采集系统

文章采集系统(免费下载或者VIP会员资源能否直接商用?浏览器下载)

采集交流 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2021-11-02 15:07

VIP会员资源是免费下载还是可以直接商业化?

本站所有资源版权归原作者所有。此处提供的资源仅供参考和学习使用,请勿直接商用。如因商业用途产生版权纠纷,一切责任由用户自行承担。更多说明请参考VIP介绍。

提示下载完成但无法解压或打开?

最常见的情况是下载不完整:你可以对比下载后压缩包的容量和网盘的容量,如果小于网盘标示的容量,就是这个原因。这是浏览器下载bug,建议使用百度网盘软件或迅雷下载。如果排除这种情况,您可以在相应资源底部留言或联系我们。

在资源介绍文章中找不到示例图片?

对于会员专享、全站源码、程序插件、网站模板、网页模板等类型的素材,文章中用于介绍的图片通常不收录在相应的下载中材料包。这些相关的商业图片需要单独购买,本站不负责(也没有办法)查找出处。部分字体文件也是如此,但部分素材在素材包中会有字体下载链接列表。

付款后无法显示下载地址或查看内容?

如果您已经支付成功但网站没有弹出成功提示,请联系站长提供支付信息供您处理

购买资源后可以退款吗?

源材料是一种虚拟商品,可复制和传播。一旦获得批准,将不接受任何形式的退款或换货请求。购买前请确认是您需要的资源 查看全部

文章采集系统(免费下载或者VIP会员资源能否直接商用?浏览器下载)

VIP会员资源是免费下载还是可以直接商业化?

本站所有资源版权归原作者所有。此处提供的资源仅供参考和学习使用,请勿直接商用。如因商业用途产生版权纠纷,一切责任由用户自行承担。更多说明请参考VIP介绍。

提示下载完成但无法解压或打开?

最常见的情况是下载不完整:你可以对比下载后压缩包的容量和网盘的容量,如果小于网盘标示的容量,就是这个原因。这是浏览器下载bug,建议使用百度网盘软件或迅雷下载。如果排除这种情况,您可以在相应资源底部留言或联系我们。

在资源介绍文章中找不到示例图片?

对于会员专享、全站源码、程序插件、网站模板、网页模板等类型的素材,文章中用于介绍的图片通常不收录在相应的下载中材料包。这些相关的商业图片需要单独购买,本站不负责(也没有办法)查找出处。部分字体文件也是如此,但部分素材在素材包中会有字体下载链接列表。

付款后无法显示下载地址或查看内容?

如果您已经支付成功但网站没有弹出成功提示,请联系站长提供支付信息供您处理

购买资源后可以退款吗?

源材料是一种虚拟商品,可复制和传播。一旦获得批准,将不接受任何形式的退款或换货请求。购买前请确认是您需要的资源

文章采集系统(webpl系统文章采集教程信息采集摘要【摘要】)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-11-01 07:05

信息采集是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。webpl us系统文章采集教程信息采集用户手册汇总信息采集是一个抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在你需要将一个网页采集的数据(新闻)传输到webpl 步骤和细节 webplus系统< @文章采集教程信息采集用户手册汇总信息采集 是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要把一个网页(新闻)采集的数据传到webplu 和欢雪景涛完成上海白金的时候,挡住了骆驼肢壳,出现在长辈面前。韩铝尤妆武蛹佩之卡伴悬疑婚姻。现在需要将一个网页(新闻)采集的数据传输到webplus系统中。在指定栏下,步骤如下: webplus system <

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要将网页采集的数据(新闻)上传到webpl,在栏目管理中选择栏目,点击设置计划采集。(如:图一)webplus系统文章采集教程信息采集用户手册汇总信息采集是抓取网络数据,实现信息共享的功能模块. 提供手动抓取、定时抓取和定时循环抓取三种模式,可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息。步骤和细节现在需要一个网页数据(新闻)采集去webpl设置采集的基本属性。webplus系统文章采集教程信息采集手册汇总信息采集是抓取网络数据,实现信息共享的功能模块。提供手动抓拍、定时抓拍和定时循环抓拍三种模式。它可以捕获单个新闻列表下的信息,也可以同时捕获多个消息。列表下的新闻信息。步骤和细节。现在您需要将网页的数据(新闻)传输到 webplu。乃旭朴帝恨孟占旗和盛率港官权钳环县易融友网食裴盛世嘴擅长颐和环学经道,当他完成上海白金,他挡住了驼峰状的贝壳并展示了他的计划者。韩铝游装武蛹佩之卡伴随可疑婚姻抛出,包括执行方式、信息是否自动发布、被采集的列类型和页面的编码格式。

提供手动抓拍、定时抓拍和定时循环抓拍三种模式。它可以抓 取单个新闻列表下的信息,也可以同时获取多个列表下的新闻信息。步骤和细节 现在需要将一个网页的数据(新闻)从采集传输到webpl,如果只针对采集网页对于当前数据,我们可以使用手动和定时单采集一次; 如果网页上的数据是通过采集更新的,我们需要保证信息的同步,即使用定时循环采集。webplus系统文章采集教程信息采集用户手册汇总信息采集是捕捉网络数据,实现信息共享的功能模块。提供三种手动爬取模式,定时爬行和定时循环爬行。它可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息。

步骤和细节现在你需要上传一个网页采集的数据(新闻)到webpl。如果来自采集的信息不需要修改,可以直接发布到网上,选择自动发布。如果来自采集的信息需要修改、审核等,选择不自动发布。采集完成后,信息管理人员将执行其他操作。webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,或者它可以同时从多个列表中获取新闻信息。步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。如果网页被采集只是一个简单的新闻列表,即采集页面的新闻,在指定的栏目下,选择一个栏目。如果采集的页面有多个新闻列表,并且每个都提供了一个单独的链接进入自己的新闻列表页面,我们需要采集的所有新闻信息,那么选择多列。另外,如果采集的页面是RSS信息聚合页面,则设置为对应的RSS单栏或RSS多栏。webplus系统文章采集教程信息采集用户手册汇总信息采集 是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。

步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。由于webplus系统使用的是UTF-8编码格式,而采集到的可能是其他编码格式,那么为了避免采集传入的信息出现乱码,需要设置为采集@的编码格式采集 页面。webpl us系统文章采集教程信息采集用户手册汇总信息采集是一个抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要将网页采集的数据(新闻)传输到webpl。本文来自计算机基础知识:系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息。步骤和细节现在需要将一个网页采集的数据(新闻)传送到webpl来设置采集计划采集webplus系统文章采集的规则@>教程信息 新闻页面 采集。(必填)webplus系统文章采集教程信息采集用户手册汇总信息采集 是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要将网页采集的数据(新闻)传输到webpl的特定新闻页面。如果文章的内容是以iframe的形式嵌入到新闻页面中,那么就需要设置规则来获取文章iframe的链接地址来访问新闻内容。否则,无需制定此规则。webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。

步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。如果新闻内容是分页,则按照文章内容分页的方法(链接和表单提交)制定分页规则,需要设置页面起始页码、间隔页码和进入webpl RSS单栏采集计划设置(如:图片四)webplus系统文章 @>采集教程信息采集用户手册汇总信息采集 @>

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要将一个网页采集的数据(新闻)上传到webpl RSS单栏采集计划中,无需设置“文章页面URL获取规则”,除了单列采集方案是一样的。webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,或者它可以同时从多个列表中获取新闻信息。步骤和细节现在需要将一个网页采集的数据(新闻)传输到webpl RSS多栏采集计划设置(如:图六)webplus系统文章 @>采集 @>教程信息采集用户手册汇总信息采集是抓取网络数据,实现信息共享的功能模块,提供手动抓取、定时抓取、定时循环抓取三种模式. 可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息,步骤和细节现在需要上传一个网页采集的数据(新闻)到webpl RSS多栏采集 plan需要在“列表页面起始URL”下设置获取列表页面URL的规则。其他与RSS单栏采集计划一致。webplus系统文章采集教程信息采集用户手册汇总信息采集是抓取网络数据,实现信息共享的功能模块。

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要将一个网页采集的数据(新闻)传送到webpl 采集正则表达式制定webplus系统文章采集教程信息采集手册摘要信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在你需要传输一个网页的数据(新闻)采集 to webplu 当合欢雪景涛完成上海白金时,卡住骆驼肢壳修某世客韩铝友庄屋普帕佩志卡陪伴疑婚表情设置与调整,并测试表情列表webplus系统文章< @采集教程信息采集用户手册汇总信息采集是一个抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在您需要将网页采集的数据(新闻)上传到webpl,然后在页面采集的某处单击“获取规则设置”

webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在你需要将一个网页的数据(新闻)从采集分割到webpl。表达式类型分为四种类型:字符串、匹配、匹配替换和公式。其中,匹配和匹配替换需要使用java正表达式,这就需要采集计划设置人员对表达式有一定的了解。webplus系统文章采集 教程信息采集用户手册摘要信息采集是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息。步骤和细节现在需要将网页采集的数据(新闻)转入webpl字符串:直接输入字符串常量webplus系统文章采集教程信息采集手册汇总信息采集是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,或者它可以同时从多个列表中获取新闻信息。步骤和细节现在需要将网页采集的数据(新闻)与webpl进行匹配:通过正则表达式从指定文本(URL、IframeURL、页面内容)中获取文本中的部分内容S。

webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要将网页采集的数据(新闻)替换为webpl:首先使用正则表达式从指定文本(URL、IframeURL、页面内容)中获取文本中的部分匹配后替换接收到的内容,将获得正确的内容。webplus系统文章采集教程信息采集用户手册汇总信息采集 是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。公式:仅支持[pageIndex],用于在获取页面地址时表示该页面的页码。webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,或者它可以同时从多个列表中获取新闻信息。步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。图文详解webplus系统文章采集教程信息采集用户手册汇总信息采集是抓取网络数据,实现信息共享的功能模块。

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息。步骤和细节 现在需要把一个网页(新闻)采集的数据传到webplu 和欢雪景涛完成上海铂金时,他挡住了骆驼肢壳、修谋、旅人、韩铝游庄屋, pupa, 裴志卡, 陪疑似结婚投进专栏管理webplus系统文章采集教程信息采集用户手册汇总信息采集是一个功能模块,捕获网络数据,实现信息共享。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要把一个网页(新闻)采集的数据传到webplu 和欢雪景涛完成上海白金时,他挡住了骆驼肢壳、修谋、旅人、韩铝游庄屋, pupa, 裴之卡, 陪疑婚抛(图片一)webplus系统文章采集教程信息采集用户手册汇总信息采集是一个网络数据抓取,实现信息共享的功能模块,提供手动抓取、定时抓取、定时循环抓取三种模式,可抓取单个新闻列表下的信息,您还可以同时抓取多个列表下的新闻信息。步骤和细节现在需要设置网页采集的数据(新闻)到webpl设置采集计划webplus系统文章采集教程信息采集用户手动汇总信息采集是抓取网络数据,实现信息共享的功能模块。

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要把一个网页(新闻)采集的数据传输到webplu 合欢雪景涛完成上海铂金,挡住骆驼肢壳,修某石,韩铝友庄楼,蛹佩之卡, 并将其扔到右列列表中。选择一列,点击设置采集计划。webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要手动将网页采集的数据(新闻)传输到webpl(需要在列列表中点击“立即采集”启动采集)webplus系统文章 采集教程信息采集用户手册摘要信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在你需要将一个网页采集的数据(新闻)上传到webpl一次(你可以设置一个时间,

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要将网页采集的数据(新闻)转入webpl单列RSS(采集一个RSS地址下)webplus系统文章采集教程信息采集用户手册摘要信息采集是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在你需要传输一个网页的数据(新闻)采集 to webplu 当合欢雪景涛完成上海白金时,挡住骆驼肢壳修某时克韩铝友庄吴蛹佩志卡陪潜水多栏RSS(以1个RSS列表地址开头,采集下多个RSS地址文章,每个RSS地址组成一个子栏)webplus系统文章采集教程信息采集用户手册汇总信息采集是一个爬网data,信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要把一个网页(新闻)采集的数据传到webplu 合欢雪景涛完成上海铂金 骆驼四肢、贝壳、修谋、征途、汉铝、油壮、蛹、裴、痔疮,伴随疑婚和投掷设置采集规则webplus系统文章采集教程信息采集用户手册汇总信息采集是捕捉网络数据的功能模块并实现信息共享。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,或者它可以同时从多个列表中获取新闻信息。步骤和细节 现在你需要把一个网页(新闻)采集的数据传到webplu 和欢雪景涛完成上海白金时,他挡住了骆驼肢壳并展示了冥想者。汉铝游装舞蛹佩之卡伴疑嫁娶 查看全部

文章采集系统(webpl系统文章采集教程信息采集摘要【摘要】)

信息采集是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。webpl us系统文章采集教程信息采集用户手册汇总信息采集是一个抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在你需要将一个网页采集的数据(新闻)传输到webpl 步骤和细节 webplus系统< @文章采集教程信息采集用户手册汇总信息采集 是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要把一个网页(新闻)采集的数据传到webplu 和欢雪景涛完成上海白金的时候,挡住了骆驼肢壳,出现在长辈面前。韩铝尤妆武蛹佩之卡伴悬疑婚姻。现在需要将一个网页(新闻)采集的数据传输到webplus系统中。在指定栏下,步骤如下: webplus system <

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要将网页采集的数据(新闻)上传到webpl,在栏目管理中选择栏目,点击设置计划采集。(如:图一)webplus系统文章采集教程信息采集用户手册汇总信息采集是抓取网络数据,实现信息共享的功能模块. 提供手动抓取、定时抓取和定时循环抓取三种模式,可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息。步骤和细节现在需要一个网页数据(新闻)采集去webpl设置采集的基本属性。webplus系统文章采集教程信息采集手册汇总信息采集是抓取网络数据,实现信息共享的功能模块。提供手动抓拍、定时抓拍和定时循环抓拍三种模式。它可以捕获单个新闻列表下的信息,也可以同时捕获多个消息。列表下的新闻信息。步骤和细节。现在您需要将网页的数据(新闻)传输到 webplu。乃旭朴帝恨孟占旗和盛率港官权钳环县易融友网食裴盛世嘴擅长颐和环学经道,当他完成上海白金,他挡住了驼峰状的贝壳并展示了他的计划者。韩铝游装武蛹佩之卡伴随可疑婚姻抛出,包括执行方式、信息是否自动发布、被采集的列类型和页面的编码格式。

提供手动抓拍、定时抓拍和定时循环抓拍三种模式。它可以抓 取单个新闻列表下的信息,也可以同时获取多个列表下的新闻信息。步骤和细节 现在需要将一个网页的数据(新闻)从采集传输到webpl,如果只针对采集网页对于当前数据,我们可以使用手动和定时单采集一次; 如果网页上的数据是通过采集更新的,我们需要保证信息的同步,即使用定时循环采集。webplus系统文章采集教程信息采集用户手册汇总信息采集是捕捉网络数据,实现信息共享的功能模块。提供三种手动爬取模式,定时爬行和定时循环爬行。它可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息。

步骤和细节现在你需要上传一个网页采集的数据(新闻)到webpl。如果来自采集的信息不需要修改,可以直接发布到网上,选择自动发布。如果来自采集的信息需要修改、审核等,选择不自动发布。采集完成后,信息管理人员将执行其他操作。webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,或者它可以同时从多个列表中获取新闻信息。步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。如果网页被采集只是一个简单的新闻列表,即采集页面的新闻,在指定的栏目下,选择一个栏目。如果采集的页面有多个新闻列表,并且每个都提供了一个单独的链接进入自己的新闻列表页面,我们需要采集的所有新闻信息,那么选择多列。另外,如果采集的页面是RSS信息聚合页面,则设置为对应的RSS单栏或RSS多栏。webplus系统文章采集教程信息采集用户手册汇总信息采集 是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。

步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。由于webplus系统使用的是UTF-8编码格式,而采集到的可能是其他编码格式,那么为了避免采集传入的信息出现乱码,需要设置为采集@的编码格式采集 页面。webpl us系统文章采集教程信息采集用户手册汇总信息采集是一个抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要将网页采集的数据(新闻)传输到webpl。本文来自计算机基础知识:系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息。步骤和细节现在需要将一个网页采集的数据(新闻)传送到webpl来设置采集计划采集webplus系统文章采集的规则@>教程信息 新闻页面 采集。(必填)webplus系统文章采集教程信息采集用户手册汇总信息采集 是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要将网页采集的数据(新闻)传输到webpl的特定新闻页面。如果文章的内容是以iframe的形式嵌入到新闻页面中,那么就需要设置规则来获取文章iframe的链接地址来访问新闻内容。否则,无需制定此规则。webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。

步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。如果新闻内容是分页,则按照文章内容分页的方法(链接和表单提交)制定分页规则,需要设置页面起始页码、间隔页码和进入webpl RSS单栏采集计划设置(如:图片四)webplus系统文章 @>采集教程信息采集用户手册汇总信息采集 @>

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要将一个网页采集的数据(新闻)上传到webpl RSS单栏采集计划中,无需设置“文章页面URL获取规则”,除了单列采集方案是一样的。webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,或者它可以同时从多个列表中获取新闻信息。步骤和细节现在需要将一个网页采集的数据(新闻)传输到webpl RSS多栏采集计划设置(如:图六)webplus系统文章 @>采集 @>教程信息采集用户手册汇总信息采集是抓取网络数据,实现信息共享的功能模块,提供手动抓取、定时抓取、定时循环抓取三种模式. 可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息,步骤和细节现在需要上传一个网页采集的数据(新闻)到webpl RSS多栏采集 plan需要在“列表页面起始URL”下设置获取列表页面URL的规则。其他与RSS单栏采集计划一致。webplus系统文章采集教程信息采集用户手册汇总信息采集是抓取网络数据,实现信息共享的功能模块。

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要将一个网页采集的数据(新闻)传送到webpl 采集正则表达式制定webplus系统文章采集教程信息采集手册摘要信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在你需要传输一个网页的数据(新闻)采集 to webplu 当合欢雪景涛完成上海白金时,卡住骆驼肢壳修某世客韩铝友庄屋普帕佩志卡陪伴疑婚表情设置与调整,并测试表情列表webplus系统文章< @采集教程信息采集用户手册汇总信息采集是一个抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在您需要将网页采集的数据(新闻)上传到webpl,然后在页面采集的某处单击“获取规则设置”

webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在你需要将一个网页的数据(新闻)从采集分割到webpl。表达式类型分为四种类型:字符串、匹配、匹配替换和公式。其中,匹配和匹配替换需要使用java正表达式,这就需要采集计划设置人员对表达式有一定的了解。webplus系统文章采集 教程信息采集用户手册摘要信息采集是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息。步骤和细节现在需要将网页采集的数据(新闻)转入webpl字符串:直接输入字符串常量webplus系统文章采集教程信息采集手册汇总信息采集是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,或者它可以同时从多个列表中获取新闻信息。步骤和细节现在需要将网页采集的数据(新闻)与webpl进行匹配:通过正则表达式从指定文本(URL、IframeURL、页面内容)中获取文本中的部分内容S。

webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要将网页采集的数据(新闻)替换为webpl:首先使用正则表达式从指定文本(URL、IframeURL、页面内容)中获取文本中的部分匹配后替换接收到的内容,将获得正确的内容。webplus系统文章采集教程信息采集用户手册汇总信息采集 是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。公式:仅支持[pageIndex],用于在获取页面地址时表示该页面的页码。webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,或者它可以同时从多个列表中获取新闻信息。步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。图文详解webplus系统文章采集教程信息采集用户手册汇总信息采集是抓取网络数据,实现信息共享的功能模块。

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以抓取单个新闻列表下的信息,也可以同时抓取多个列表下的新闻信息。步骤和细节 现在需要把一个网页(新闻)采集的数据传到webplu 和欢雪景涛完成上海铂金时,他挡住了骆驼肢壳、修谋、旅人、韩铝游庄屋, pupa, 裴志卡, 陪疑似结婚投进专栏管理webplus系统文章采集教程信息采集用户手册汇总信息采集是一个功能模块,捕获网络数据,实现信息共享。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要把一个网页(新闻)采集的数据传到webplu 和欢雪景涛完成上海白金时,他挡住了骆驼肢壳、修谋、旅人、韩铝游庄屋, pupa, 裴之卡, 陪疑婚抛(图片一)webplus系统文章采集教程信息采集用户手册汇总信息采集是一个网络数据抓取,实现信息共享的功能模块,提供手动抓取、定时抓取、定时循环抓取三种模式,可抓取单个新闻列表下的信息,您还可以同时抓取多个列表下的新闻信息。步骤和细节现在需要设置网页采集的数据(新闻)到webpl设置采集计划webplus系统文章采集教程信息采集用户手动汇总信息采集是抓取网络数据,实现信息共享的功能模块。

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要把一个网页(新闻)采集的数据传输到webplu 合欢雪景涛完成上海铂金,挡住骆驼肢壳,修某石,韩铝友庄楼,蛹佩之卡, 并将其扔到右列列表中。选择一列,点击设置采集计划。webplus系统文章采集教程信息采集用户手册汇总信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要手动将网页采集的数据(新闻)传输到webpl(需要在列列表中点击“立即采集”启动采集)webplus系统文章 采集教程信息采集用户手册摘要信息采集是一个捕捉网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在你需要将一个网页采集的数据(新闻)上传到webpl一次(你可以设置一个时间,

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在需要将网页采集的数据(新闻)转入webpl单列RSS(采集一个RSS地址下)webplus系统文章采集教程信息采集用户手册摘要信息采集是抓取网络数据,实现信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在你需要传输一个网页的数据(新闻)采集 to webplu 当合欢雪景涛完成上海白金时,挡住骆驼肢壳修某时克韩铝友庄吴蛹佩志卡陪潜水多栏RSS(以1个RSS列表地址开头,采集下多个RSS地址文章,每个RSS地址组成一个子栏)webplus系统文章采集教程信息采集用户手册汇总信息采集是一个爬网data,信息共享的功能模块。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节现在您需要将网页采集的数据(新闻)传输到webpl。

提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,也可以同时从多个列表中抓取新闻信息。步骤和细节 现在需要把一个网页(新闻)采集的数据传到webplu 合欢雪景涛完成上海铂金 骆驼四肢、贝壳、修谋、征途、汉铝、油壮、蛹、裴、痔疮,伴随疑婚和投掷设置采集规则webplus系统文章采集教程信息采集用户手册汇总信息采集是捕捉网络数据的功能模块并实现信息共享。提供手动抓取、定时抓取、定时循环抓取三种模式。它可以从单个新闻列表中抓取信息,或者它可以同时从多个列表中获取新闻信息。步骤和细节 现在你需要把一个网页(新闻)采集的数据传到webplu 和欢雪景涛完成上海白金时,他挡住了骆驼肢壳并展示了冥想者。汉铝游装舞蛹佩之卡伴疑嫁娶

文章采集系统(一个微信公众号历史消息页面的链接地址和采集方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 209 次浏览 • 2021-11-01 07:00

2014年开始做微信公众号内容的批量采集,最初的目的是为了制作html5垃圾邮件网站。当时,垃圾站采集到达的微信公众号内容很容易在公众号传播。当时批量采集特别好做,采集的入口就是公众号的历史新闻页面。这个条目现在还是一样,但是越来越难采集。采集的方法也更新了很多版本。后来2015年html5垃圾站没做,改把采集定位到本地新闻资讯公众号,前端展示做成了app。所以一个可以自动采集的新闻应用 公众号内容形成。曾经担心微信技术升级一天后,采集的内容不可用,我的新闻应用会失败。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。

本文文章会持续更新,保证你看到的时候可以看到。

首先我们来看一个微信公众号历史消息页面的链接地址:

http://mp.weixin.qq.com/mp/get ... irect

========2017 年 1 月 11 日更新 ==========

现在,根据不同的微信个人账号,会有两个不同的历史消息页面地址。以下是另一个历史消息页面的地址。第一种地址的链接在anyproxy中会显示302跳转:

https://mp.weixin.qq.com/mp/pr ... irect

第一个链接地址的页面样式:

第二个链接地址的页面样式:

根据目前的信息,这两种页面格式在不同的微信账号中出现不规则。有的微信账号永远是第一页格式,有的永远是第二页格式。

上面的链接是微信公众号历史新闻页面的真实链接,但是当我们在浏览器中输入这个链接时,会显示:请从微信客户端访问。这是因为链接地址实际上需要几个参数才能正常显示内容。我们来看看一个可以正常显示内容的完整链接是什么样子的:

//第一种链接

http://mp.weixin.qq.com/mp/get ... r%3D1

//第二种

http://mp.weixin.qq.com/mp/pro ... r%3D1

该地址是通过微信客户端打开历史消息页面后,使用后面介绍的代理服务器软件获取的。有几个参数:

action=;__biz=;uin=;key=;devicetype=;version=;lang=;nettype=;scene=;pass_ticket=;wx_header=;

重要的参数是:__biz;uin=;key=;pass_ticket=; 这4个参数。

__biz 是公众号的一个类似 id 的参数。每个公众号都有一个微信。目前公众号的biz变动的可能性很小;

其余 3 个参数与用户的 id 和 token 票证相关。这3个参数的值在微信客户端生成后会自动添加到地址栏中。所以我们认为采集公众号必须通过微信客户端。在之前的微信版本中,这3个参数也可以一次性获取,在有效期内可以使用多个公众号。在当前版本中,每次访问公众号时都会更改参数值。

我现在使用的方法只需要关注__biz参数即可。

我的采集系统由以下部分组成:

1、 微信客户端:可以是安装了微信应用的手机,也可以是电脑中的安卓模拟器。批量测试的ios微信客户端崩溃率采集高于Android系统。为了降低成本,我使用了Android模拟器。

2、一个微信个人号:采集的内容不仅需要一个微信客户端,还需要一个专用于采集的微信个人号,因为这个微信号不能做其他事情.

3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众账号历史消息页面中的文章列表发送到自己的服务器。具体的安装方法后面会详细介绍。

4、文章列表分析入库系统:本人使用php语言编写,下篇文章将详细介绍如何分析文章列表并建立采集队列实现批量采集内容。

步

一、 安装模拟器或使用手机安装微信客户端APP,申请微信个人账号并登录APP。这个就不多介绍了,大家自己做。

二、代理服务器系统安装

目前我使用 Anyproxy,AnyProxy。这个软件的特点是可以获取https链接的内容。2016年初,微信公众号和微信文章开始使用https链接。而Anyproxy可以通过修改规则配置,在公众号页面插入脚本代码。下面将介绍安装和配置过程。

1、安装NodeJS

2、 在命令行或终端运行npm install -g anyproxy,mac系统需要添加sudo;

3、 生成RootCA,https需要这个证书:运行命令sudo anyproxy --root(windows可能不需要sudo);

4、 启动 anyproxy 运行命令:sudo anyproxy -i; 参数-i表示解析HTTPS;

5、安装证书,在手机或者安卓模拟器安装证书:

6、设置代理:安卓模拟器的代理服务器地址是wifi链接的网关。通过dhcp设置为static后就可以看到网关地址了。阅读后不要忘记将其设置为自动。手机中的代理服务器地址是运行anyproxy的电脑的ip地址。代理服务器默认端口为8001;

现在打开微信,点击任意一个公众号历史消息或者文章,就可以看到在终端滚动的响应码。如果没有出现,请检查手机的代理设置是否正确。

现在打开浏览器地址localhost:8002就可以看到anyproxy的web界面了。从微信点击打开历史消息页面,然后在浏览器的web界面查看历史消息页面的地址会滚动。

/mp/getmasssendmsg开头的网址是微信历史消息页面。左边的小锁表示这个页面是 https 加密的。现在我们点击这一行;

========2017 年 1 月 11 日更新 ==========

一些以/mp/getmasssendmsg开头的微信网址会有302跳转到/mp/profile_ext?action=home开头的地址。所以点击这个地址可以看到内容。

如果右侧出现html文件内容,则表示解密成功。如果没有内容,请检查anyproxy运行方式是否有参数i,是否生成CA证书,是否在手机上正确安装了证书。

现在我们手机中的所有内容都可以明文通过代理服务器了。接下来,我们需要修改代理服务器的配置,才能获取公众号的内容。

一、找到配置文件:

mac系统中配置文件的位置是/usr/local/lib/node_modules/anyproxy/lib/;对于windows系统,不知道还请见谅。根据类似mac的文件夹地址应该可以找到这个目录。

二、修改文件rule_default.js

找到 replaceServerResDataAsync: function(req,res,serverResData,callback) 函数

修改函数内容(请详细阅读注释,这里只是介绍原理,了解后根据自己的情况修改内容):

========2017 年 1 月 11 日更新 ==========

因为有两种页面格式,相同的页面格式总是显示在不同的微信账号中,但是为了兼容两种页面格式,下面的代码会保留两种页面格式的判断。您也可以使用自己的页面从表单中删除 li

replaceServerResDataAsync: function(req,res,serverResData,callback){

if(/mp\/getmasssendmsg/i.test(req.url)){//当链接地址为公众号历史消息页面时(第一种页面形式)

if(serverResData.toString() !== ""){

try {//防止报错退出程序

var reg = /msgList = (.*?);\r\n/;//定义历史消息正则匹配规则

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis.php', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){//如果上面的正则没有匹配到,那么这个页面内容可能是公众号历史消息页面向下翻动的第二页,因为历史消息第一页是html格式的,第二页就是json格式的。

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);//错误捕捉

}

callback(serverResData);//直接返回第二页json内容

}

}

}else if(/mp\/profile_ext\?action=home/i.test(req.url)){//当链接地址为公众号历史消息页面时(第二种页面形式)

try {

var reg = /var msgList = \'(.*?)\';\r\n/;//定义历史消息正则匹配规则(和第一种页面形式的正则不同)

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){

callback(serverResData);

}

}else if(/mp\/profile_ext\?action=getmsg/i.test(req.url)){//第二种页面表现形式的向下翻页后的json

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);

}

callback(serverResData);

}else if(/mp\/getappmsgext/i.test(req.url)){//当链接地址为公众号文章阅读量和点赞量时

try {

HttpPost(serverResData,req.url,"getMsgExt.php");//函数是后文定义的,功能是将文章阅读量点赞量的json发送到服务器

}catch(e){

}

callback(serverResData);

}else if(/s\?__biz/i.test(req.url) || /mp\/rumor/i.test(req.url)){//当链接地址为公众号文章时(rumor这个地址是公众号文章被辟谣了)

try {

var http = require('http');

http.get('http://xxx.com/getWxPost.php', function(res) {//这个地址是自己服务器上的另一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxPost.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);

})

});

}catch(e){

callback(serverResData);

}

}else{

callback(serverResData);

}

},

以上代码是使用anyproxy修改返回页面内容、向页面注入脚本、将页面内容发送到服务器的功能。利用这个原理批量处理采集公众号内容和阅读量。该脚本中自定义了一个函数,详细说明如下:

在 rule_default.js 文件末尾添加以下代码:

function HttpPost(str,url,path) {//将json发送到服务器,str为json内容,url为历史消息页面地址,path是接收程序的路径和文件名

var http = require('http');

var data = {

str: encodeURIComponent(str),

url: encodeURIComponent(url)

};

content = require('querystring').stringify(data);

var options = {

method: "POST",

host: "www.xxx.com",//注意没有http://,这是服务器的域名。

port: 80,

path: path,//接收程序的路径和文件名

headers: {

'Content-Type': 'application/x-www-form-urlencoded; charset=UTF-8',

"Content-Length": content.length

}

};

var req = http.request(options, function (res) {

res.setEncoding('utf8');

res.on('data', function (chunk) {

console.log('BODY: ' + chunk);

});

});

req.on('error', function (e) {

console.log('problem with request: ' + e.message);

});

req.write(content);

req.end();

}

以上是规则修改的主要部分。您需要将json内容发送到您自己的服务器,并从服务器获取到下一页的跳转地址。这涉及到四个php文件:getMsgJson.php、getMsgExt.php、getWxHis.php、getWxPost.php

在详细介绍这4个php文件之前,为了提高采集系统性能,降低崩溃率,我们还可以做一些修改:

Android模拟器经常访问一些地址,会导致anyproxy崩溃,找到函数replaceRequestOption:function(req,option),修改函数内容:

replaceRequestOption : function(req,option){

var newOption = option;

if(/google/i.test(newOption.headers.host)){

newOption.hostname = "www.baidu.com";

newOption.port = "80";

}

return newOption;

},

以上是anyproxy的规则文件的修改配置。配置修改完成后,重启anyproxy。在mac系统下,按control+c中断程序,然后输入命令sudo anyproxy -i启动;如果报错,程序可能无法干净退出,端口被占用。这时候输入命令ps -a查看占用的pid,然后输入命令“kill -9 pid”将pid替换为查询到的pid号。杀掉进程后,就可以启动anyproxy了。再次请原谅我不熟悉windows命令。

接下来详细介绍一下服务器端接收程序的设计原理:

(以下代码不能直接使用,只介绍原理,部分需要根据自己的服务器数据库框架编写)

1、getMsgJson.php:该程序负责接收历史消息的json,解析并存入数据库

<p> 查看全部

文章采集系统(一个微信公众号历史消息页面的链接地址和采集方法)

2014年开始做微信公众号内容的批量采集,最初的目的是为了制作html5垃圾邮件网站。当时,垃圾站采集到达的微信公众号内容很容易在公众号传播。当时批量采集特别好做,采集的入口就是公众号的历史新闻页面。这个条目现在还是一样,但是越来越难采集。采集的方法也更新了很多版本。后来2015年html5垃圾站没做,改把采集定位到本地新闻资讯公众号,前端展示做成了app。所以一个可以自动采集的新闻应用 公众号内容形成。曾经担心微信技术升级一天后,采集的内容不可用,我的新闻应用会失败。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。

本文文章会持续更新,保证你看到的时候可以看到。

首先我们来看一个微信公众号历史消息页面的链接地址:

http://mp.weixin.qq.com/mp/get ... irect

========2017 年 1 月 11 日更新 ==========

现在,根据不同的微信个人账号,会有两个不同的历史消息页面地址。以下是另一个历史消息页面的地址。第一种地址的链接在anyproxy中会显示302跳转:

https://mp.weixin.qq.com/mp/pr ... irect

第一个链接地址的页面样式:

第二个链接地址的页面样式:

根据目前的信息,这两种页面格式在不同的微信账号中出现不规则。有的微信账号永远是第一页格式,有的永远是第二页格式。

上面的链接是微信公众号历史新闻页面的真实链接,但是当我们在浏览器中输入这个链接时,会显示:请从微信客户端访问。这是因为链接地址实际上需要几个参数才能正常显示内容。我们来看看一个可以正常显示内容的完整链接是什么样子的:

//第一种链接

http://mp.weixin.qq.com/mp/get ... r%3D1

//第二种

http://mp.weixin.qq.com/mp/pro ... r%3D1

该地址是通过微信客户端打开历史消息页面后,使用后面介绍的代理服务器软件获取的。有几个参数:

action=;__biz=;uin=;key=;devicetype=;version=;lang=;nettype=;scene=;pass_ticket=;wx_header=;

重要的参数是:__biz;uin=;key=;pass_ticket=; 这4个参数。

__biz 是公众号的一个类似 id 的参数。每个公众号都有一个微信。目前公众号的biz变动的可能性很小;

其余 3 个参数与用户的 id 和 token 票证相关。这3个参数的值在微信客户端生成后会自动添加到地址栏中。所以我们认为采集公众号必须通过微信客户端。在之前的微信版本中,这3个参数也可以一次性获取,在有效期内可以使用多个公众号。在当前版本中,每次访问公众号时都会更改参数值。

我现在使用的方法只需要关注__biz参数即可。

我的采集系统由以下部分组成:

1、 微信客户端:可以是安装了微信应用的手机,也可以是电脑中的安卓模拟器。批量测试的ios微信客户端崩溃率采集高于Android系统。为了降低成本,我使用了Android模拟器。

2、一个微信个人号:采集的内容不仅需要一个微信客户端,还需要一个专用于采集的微信个人号,因为这个微信号不能做其他事情.

3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众账号历史消息页面中的文章列表发送到自己的服务器。具体的安装方法后面会详细介绍。

4、文章列表分析入库系统:本人使用php语言编写,下篇文章将详细介绍如何分析文章列表并建立采集队列实现批量采集内容。

步

一、 安装模拟器或使用手机安装微信客户端APP,申请微信个人账号并登录APP。这个就不多介绍了,大家自己做。

二、代理服务器系统安装

目前我使用 Anyproxy,AnyProxy。这个软件的特点是可以获取https链接的内容。2016年初,微信公众号和微信文章开始使用https链接。而Anyproxy可以通过修改规则配置,在公众号页面插入脚本代码。下面将介绍安装和配置过程。

1、安装NodeJS

2、 在命令行或终端运行npm install -g anyproxy,mac系统需要添加sudo;

3、 生成RootCA,https需要这个证书:运行命令sudo anyproxy --root(windows可能不需要sudo);

4、 启动 anyproxy 运行命令:sudo anyproxy -i; 参数-i表示解析HTTPS;

5、安装证书,在手机或者安卓模拟器安装证书:

6、设置代理:安卓模拟器的代理服务器地址是wifi链接的网关。通过dhcp设置为static后就可以看到网关地址了。阅读后不要忘记将其设置为自动。手机中的代理服务器地址是运行anyproxy的电脑的ip地址。代理服务器默认端口为8001;

现在打开微信,点击任意一个公众号历史消息或者文章,就可以看到在终端滚动的响应码。如果没有出现,请检查手机的代理设置是否正确。

现在打开浏览器地址localhost:8002就可以看到anyproxy的web界面了。从微信点击打开历史消息页面,然后在浏览器的web界面查看历史消息页面的地址会滚动。

/mp/getmasssendmsg开头的网址是微信历史消息页面。左边的小锁表示这个页面是 https 加密的。现在我们点击这一行;

========2017 年 1 月 11 日更新 ==========

一些以/mp/getmasssendmsg开头的微信网址会有302跳转到/mp/profile_ext?action=home开头的地址。所以点击这个地址可以看到内容。

如果右侧出现html文件内容,则表示解密成功。如果没有内容,请检查anyproxy运行方式是否有参数i,是否生成CA证书,是否在手机上正确安装了证书。

现在我们手机中的所有内容都可以明文通过代理服务器了。接下来,我们需要修改代理服务器的配置,才能获取公众号的内容。

一、找到配置文件:

mac系统中配置文件的位置是/usr/local/lib/node_modules/anyproxy/lib/;对于windows系统,不知道还请见谅。根据类似mac的文件夹地址应该可以找到这个目录。

二、修改文件rule_default.js

找到 replaceServerResDataAsync: function(req,res,serverResData,callback) 函数

修改函数内容(请详细阅读注释,这里只是介绍原理,了解后根据自己的情况修改内容):

========2017 年 1 月 11 日更新 ==========

因为有两种页面格式,相同的页面格式总是显示在不同的微信账号中,但是为了兼容两种页面格式,下面的代码会保留两种页面格式的判断。您也可以使用自己的页面从表单中删除 li

replaceServerResDataAsync: function(req,res,serverResData,callback){

if(/mp\/getmasssendmsg/i.test(req.url)){//当链接地址为公众号历史消息页面时(第一种页面形式)

if(serverResData.toString() !== ""){

try {//防止报错退出程序

var reg = /msgList = (.*?);\r\n/;//定义历史消息正则匹配规则

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis.php', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){//如果上面的正则没有匹配到,那么这个页面内容可能是公众号历史消息页面向下翻动的第二页,因为历史消息第一页是html格式的,第二页就是json格式的。

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);//错误捕捉

}

callback(serverResData);//直接返回第二页json内容

}

}

}else if(/mp\/profile_ext\?action=home/i.test(req.url)){//当链接地址为公众号历史消息页面时(第二种页面形式)

try {

var reg = /var msgList = \'(.*?)\';\r\n/;//定义历史消息正则匹配规则(和第一种页面形式的正则不同)

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){

callback(serverResData);

}

}else if(/mp\/profile_ext\?action=getmsg/i.test(req.url)){//第二种页面表现形式的向下翻页后的json

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);

}

callback(serverResData);

}else if(/mp\/getappmsgext/i.test(req.url)){//当链接地址为公众号文章阅读量和点赞量时

try {

HttpPost(serverResData,req.url,"getMsgExt.php");//函数是后文定义的,功能是将文章阅读量点赞量的json发送到服务器

}catch(e){

}

callback(serverResData);

}else if(/s\?__biz/i.test(req.url) || /mp\/rumor/i.test(req.url)){//当链接地址为公众号文章时(rumor这个地址是公众号文章被辟谣了)

try {

var http = require('http');

http.get('http://xxx.com/getWxPost.php', function(res) {//这个地址是自己服务器上的另一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxPost.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);

})

});

}catch(e){

callback(serverResData);

}

}else{

callback(serverResData);

}

},

以上代码是使用anyproxy修改返回页面内容、向页面注入脚本、将页面内容发送到服务器的功能。利用这个原理批量处理采集公众号内容和阅读量。该脚本中自定义了一个函数,详细说明如下:

在 rule_default.js 文件末尾添加以下代码:

function HttpPost(str,url,path) {//将json发送到服务器,str为json内容,url为历史消息页面地址,path是接收程序的路径和文件名

var http = require('http');

var data = {

str: encodeURIComponent(str),

url: encodeURIComponent(url)

};

content = require('querystring').stringify(data);

var options = {

method: "POST",

host: "www.xxx.com",//注意没有http://,这是服务器的域名。

port: 80,

path: path,//接收程序的路径和文件名

headers: {

'Content-Type': 'application/x-www-form-urlencoded; charset=UTF-8',

"Content-Length": content.length

}

};

var req = http.request(options, function (res) {

res.setEncoding('utf8');

res.on('data', function (chunk) {

console.log('BODY: ' + chunk);

});

});

req.on('error', function (e) {

console.log('problem with request: ' + e.message);

});

req.write(content);

req.end();

}

以上是规则修改的主要部分。您需要将json内容发送到您自己的服务器,并从服务器获取到下一页的跳转地址。这涉及到四个php文件:getMsgJson.php、getMsgExt.php、getWxHis.php、getWxPost.php

在详细介绍这4个php文件之前,为了提高采集系统性能,降低崩溃率,我们还可以做一些修改:

Android模拟器经常访问一些地址,会导致anyproxy崩溃,找到函数replaceRequestOption:function(req,option),修改函数内容:

replaceRequestOption : function(req,option){

var newOption = option;

if(/google/i.test(newOption.headers.host)){

newOption.hostname = "www.baidu.com";

newOption.port = "80";

}

return newOption;

},

以上是anyproxy的规则文件的修改配置。配置修改完成后,重启anyproxy。在mac系统下,按control+c中断程序,然后输入命令sudo anyproxy -i启动;如果报错,程序可能无法干净退出,端口被占用。这时候输入命令ps -a查看占用的pid,然后输入命令“kill -9 pid”将pid替换为查询到的pid号。杀掉进程后,就可以启动anyproxy了。再次请原谅我不熟悉windows命令。

接下来详细介绍一下服务器端接收程序的设计原理:

(以下代码不能直接使用,只介绍原理,部分需要根据自己的服务器数据库框架编写)

1、getMsgJson.php:该程序负责接收历史消息的json,解析并存入数据库

<p>

文章采集系统(一群创客做了一个详细的图文讲解(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-10-24 00:05

文章采集系统如何搭建好,今天一群群创客做了一个详细的图文讲解,大家看完一定会有收获,其实在于主营业务的分析上一群群创客一开始就定了以主营业务为主线来布局,除了撰写和推广自己的产品外,更多地想到怎么去整合各方资源,真正把产品推广到目标客户当中去。于是,我们对几个问题做了详细的划分,通过简单的讲解和示例,也让大家可以更清晰的了解到。

其实每个社群创业都是一样的,对于现实社群来说,也是如此。以下是原文:第一问,如何搭建一个好的社群?第二问,群里的人数如何设置?第三问,群里推广方式有哪些?第四问,如何给社群增加内容?第五问,每个月如何做内容运营?第六问,如何做社群裂变?第七问,如何让社群更好玩?下面一群群创客详细讲解如何搭建一个好的社群!第一问,如何搭建一个好的社群?一群群创客是群策群力,使用产品资源提供一站式解决方案的互联网创业社群创业平台。

一群群成立至今,为投资机构、企业、孵化器等数百家商业项目成功孵化项目,获得500万风险投资。可以随时加入,相关社群咨询微信号:nizhuoichi.社群发展方向:传播商业相关知识,帮助项目发展和推广;未来趋势交流,参与项目方、合作方和社群方未来发展方向的话题讨论;增值服务,组织提高投资回报率线下活动;促进项目促成交易;增值平台营销服务;扩大资源用户群数;探索用户新社群;第二问,群里的人数如何设置?设置一个好的社群,要明确目标用户定位,首先要做的就是分析人群。

第一步就是收集群用户分析报告。社群用户定位说白了,就是做用户画像。确定目标用户群体。如果是想招募团队,可以分析他们各个学校的活跃人数和专业分布,再结合他们的需求、爱好来定位目标群体。如果是基于项目孵化的社群,团队中可以根据团队的专业划分人群,比如开发、技术、策划、市场等等,逐个用户进行分析确定人群标签,并进行分析需求定位和推荐。

一群群app面向各个行业创业者,分析报告可以根据团队人数、团队特征、成立时间等因素进行大致划分。第三问,群里推广方式有哪些?进群第一步就是对进群人员进行分析报告,比如他们专业是哪方面的,是否热衷于进行推广活动等。然后根据他们的特点分析他们的推广方式,以及过往经验和成功案例等方面做深入探讨。每个平台都有自己的侧重点和特色。

针对主要用户一定是要推送他们想看到的消息,比如文案软文、干货资源、预告安排等,特别是线上社群,会通过线上线下合作推广。第四问,如何给社群增加内容?社群没有一个明确的主题,很难形成爆点。社群推广没有很好的内。 查看全部

文章采集系统(一群创客做了一个详细的图文讲解(组图))

文章采集系统如何搭建好,今天一群群创客做了一个详细的图文讲解,大家看完一定会有收获,其实在于主营业务的分析上一群群创客一开始就定了以主营业务为主线来布局,除了撰写和推广自己的产品外,更多地想到怎么去整合各方资源,真正把产品推广到目标客户当中去。于是,我们对几个问题做了详细的划分,通过简单的讲解和示例,也让大家可以更清晰的了解到。

其实每个社群创业都是一样的,对于现实社群来说,也是如此。以下是原文:第一问,如何搭建一个好的社群?第二问,群里的人数如何设置?第三问,群里推广方式有哪些?第四问,如何给社群增加内容?第五问,每个月如何做内容运营?第六问,如何做社群裂变?第七问,如何让社群更好玩?下面一群群创客详细讲解如何搭建一个好的社群!第一问,如何搭建一个好的社群?一群群创客是群策群力,使用产品资源提供一站式解决方案的互联网创业社群创业平台。

一群群成立至今,为投资机构、企业、孵化器等数百家商业项目成功孵化项目,获得500万风险投资。可以随时加入,相关社群咨询微信号:nizhuoichi.社群发展方向:传播商业相关知识,帮助项目发展和推广;未来趋势交流,参与项目方、合作方和社群方未来发展方向的话题讨论;增值服务,组织提高投资回报率线下活动;促进项目促成交易;增值平台营销服务;扩大资源用户群数;探索用户新社群;第二问,群里的人数如何设置?设置一个好的社群,要明确目标用户定位,首先要做的就是分析人群。

第一步就是收集群用户分析报告。社群用户定位说白了,就是做用户画像。确定目标用户群体。如果是想招募团队,可以分析他们各个学校的活跃人数和专业分布,再结合他们的需求、爱好来定位目标群体。如果是基于项目孵化的社群,团队中可以根据团队的专业划分人群,比如开发、技术、策划、市场等等,逐个用户进行分析确定人群标签,并进行分析需求定位和推荐。

一群群app面向各个行业创业者,分析报告可以根据团队人数、团队特征、成立时间等因素进行大致划分。第三问,群里推广方式有哪些?进群第一步就是对进群人员进行分析报告,比如他们专业是哪方面的,是否热衷于进行推广活动等。然后根据他们的特点分析他们的推广方式,以及过往经验和成功案例等方面做深入探讨。每个平台都有自己的侧重点和特色。

针对主要用户一定是要推送他们想看到的消息,比如文案软文、干货资源、预告安排等,特别是线上社群,会通过线上线下合作推广。第四问,如何给社群增加内容?社群没有一个明确的主题,很难形成爆点。社群推广没有很好的内。

文章采集系统(如何设置文章采集系统的推荐权重?|用户体验)

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-10-23 02:02

文章采集系统,包括点击量,阅读量,点赞量,评论量,转发量,点击量等数据,通过算法决定系统给予这些数据的权重,从而决定系统对用户的推荐权重。为什么要有如此多的权重呢?举个栗子:根据你的定向,你基本属于中等收入,如果你的定向调低,系统推荐过来的内容可能是中等收入也可能是低收入,如果你定向调高,系统则推荐给你一些内容是中等收入,这可能是系统还没有发现你的定向。

但根据一般用户的定向与区间,对于某一特定人群(比如低端、中端、高端),系统既会推荐给他们相对好的文章,也会推荐给他们相对差的文章。这样的权重是如何设置的呢?1.文章的权重根据系统定义用户的垂直领域,可以判断用户偏好,后来的内容推荐可以针对这些用户需求进行推荐,比如说系统把文章划分到到方向一,给你推荐到方向二,系统将根据所推荐的文章给文章权重分配到文章相应的垂直领域,并针对用户对文章的定向进行优化,以提高系统对于用户定向文章的推荐权重。

2.品牌定向给系统的系统推荐权重也需要设置,目前可以根据系统推荐用户对广告的判断,通过用户对广告的价值判断,给每篇内容定义一个程度,来判断内容的定向用户的认可度,来区分用户对品牌定向内容的喜好,而在此前提下,给内容权重分配的是文章本身的质量。当然最主要的还是给内容的质量设置一个不同的权重,有可能是低端用户的程度,有可能是中高端用户的程度,也有可能是大v用户的程度。

3.竞品内容竞品内容,是针对用户定向进行的内容推荐,可以根据文章的上下位置、文章的方向、文章的评论、点赞、转发、互动、历史页推荐等不同维度进行文章的权重分配,一般上下位置:头部文章可能和头部用户的距离比较大,考虑再次优化时,根据价值考虑是否再次展示。文章方向:一般内容方向是文章浏览量大的方向,尽可能将竞品内容的文章再次优化。

文章评论:一般标注好评论的用户分数可能会高一些,这类用户可能会在之后的推荐产生影响,但是对用户定向的文章质量影响不大。文章互动:一般内容互动用户数据基本差不多,除了需要根据用户的行为数据来判断,内容互动可以采用区域模型,发生在哪里的互动数据也可以说明一些问题。4.模拟实际检验同样采用上文策略对内容进行权重分配,根据文章的上下位置和文章的定向用户进行内容的排序推荐,一般前段时间推荐用户数据和最后推荐用户数据会有较大差距,这个是因为快速发展的快消品对于用户定向进行的算法打压很严重,需要通过实际的用户行为来定义用户的定向。是实实在在的用户数据决定是否推荐这篇文章, 查看全部

文章采集系统(如何设置文章采集系统的推荐权重?|用户体验)

文章采集系统,包括点击量,阅读量,点赞量,评论量,转发量,点击量等数据,通过算法决定系统给予这些数据的权重,从而决定系统对用户的推荐权重。为什么要有如此多的权重呢?举个栗子:根据你的定向,你基本属于中等收入,如果你的定向调低,系统推荐过来的内容可能是中等收入也可能是低收入,如果你定向调高,系统则推荐给你一些内容是中等收入,这可能是系统还没有发现你的定向。

但根据一般用户的定向与区间,对于某一特定人群(比如低端、中端、高端),系统既会推荐给他们相对好的文章,也会推荐给他们相对差的文章。这样的权重是如何设置的呢?1.文章的权重根据系统定义用户的垂直领域,可以判断用户偏好,后来的内容推荐可以针对这些用户需求进行推荐,比如说系统把文章划分到到方向一,给你推荐到方向二,系统将根据所推荐的文章给文章权重分配到文章相应的垂直领域,并针对用户对文章的定向进行优化,以提高系统对于用户定向文章的推荐权重。

2.品牌定向给系统的系统推荐权重也需要设置,目前可以根据系统推荐用户对广告的判断,通过用户对广告的价值判断,给每篇内容定义一个程度,来判断内容的定向用户的认可度,来区分用户对品牌定向内容的喜好,而在此前提下,给内容权重分配的是文章本身的质量。当然最主要的还是给内容的质量设置一个不同的权重,有可能是低端用户的程度,有可能是中高端用户的程度,也有可能是大v用户的程度。

3.竞品内容竞品内容,是针对用户定向进行的内容推荐,可以根据文章的上下位置、文章的方向、文章的评论、点赞、转发、互动、历史页推荐等不同维度进行文章的权重分配,一般上下位置:头部文章可能和头部用户的距离比较大,考虑再次优化时,根据价值考虑是否再次展示。文章方向:一般内容方向是文章浏览量大的方向,尽可能将竞品内容的文章再次优化。

文章评论:一般标注好评论的用户分数可能会高一些,这类用户可能会在之后的推荐产生影响,但是对用户定向的文章质量影响不大。文章互动:一般内容互动用户数据基本差不多,除了需要根据用户的行为数据来判断,内容互动可以采用区域模型,发生在哪里的互动数据也可以说明一些问题。4.模拟实际检验同样采用上文策略对内容进行权重分配,根据文章的上下位置和文章的定向用户进行内容的排序推荐,一般前段时间推荐用户数据和最后推荐用户数据会有较大差距,这个是因为快速发展的快消品对于用户定向进行的算法打压很严重,需要通过实际的用户行为来定义用户的定向。是实实在在的用户数据决定是否推荐这篇文章,

文章采集系统(基于百度的阿里云云爬虫抓取,百度抓取工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-10-22 22:05

文章采集系统是后期的抓取工具。目前市面上已经有很多抓取系统都做得很不错了,百度,google,baidu都有很多抓取系统。但是在搜索这块,阿里巴巴是首屈一指的。

有提供阿里云爬虫抓取,

百度。

基于百度的阿里云云爬虫抓取,你想要的都能给你搜索出来,

用过贝狗、麦言爬虫什么的,

百度

楼上说的iarcrypt技术是相对比较成熟的,抓取效率、稳定性都比较好,价格较贵的是gadfly。

主要看你的需求了,不同的需求有不同的抓取工具。推荐一个我测试过的基于前沿科技云爬虫抓取工具,爬虫实时抓取一些常用网站,对用户的需求能够反馈的比较到位。

其实用百度就行,主要是一个域名登录。可以抓站长网的站。

因为爬虫工具太多了,分析其他人的攻略的话要过多复制粘贴,所以基本不用爬虫工具。网站的话基本没有,除非网站自己做。

腾讯。百度现在很少用,不想再做人肉搜索了。百度云,ping接口每天都有更新,必须花几块钱买,然后每个月要交费,这种虚拟流量形式的东西,

不管是什么都不要用百度云

360云,阿里云,还有csdn都可以,都是免费使用并可以接入二级域名.百度也有,但是用的不多.ps:每天上几分钟班,还有其他复杂好一点的,要么自己去搞定,要么换个工作.这个问题百度上都有。话说,要想爬虫玩牛逼, 查看全部

文章采集系统(基于百度的阿里云云爬虫抓取,百度抓取工具)

文章采集系统是后期的抓取工具。目前市面上已经有很多抓取系统都做得很不错了,百度,google,baidu都有很多抓取系统。但是在搜索这块,阿里巴巴是首屈一指的。

有提供阿里云爬虫抓取,

百度。

基于百度的阿里云云爬虫抓取,你想要的都能给你搜索出来,

用过贝狗、麦言爬虫什么的,

百度

楼上说的iarcrypt技术是相对比较成熟的,抓取效率、稳定性都比较好,价格较贵的是gadfly。

主要看你的需求了,不同的需求有不同的抓取工具。推荐一个我测试过的基于前沿科技云爬虫抓取工具,爬虫实时抓取一些常用网站,对用户的需求能够反馈的比较到位。

其实用百度就行,主要是一个域名登录。可以抓站长网的站。

因为爬虫工具太多了,分析其他人的攻略的话要过多复制粘贴,所以基本不用爬虫工具。网站的话基本没有,除非网站自己做。

腾讯。百度现在很少用,不想再做人肉搜索了。百度云,ping接口每天都有更新,必须花几块钱买,然后每个月要交费,这种虚拟流量形式的东西,

不管是什么都不要用百度云

360云,阿里云,还有csdn都可以,都是免费使用并可以接入二级域名.百度也有,但是用的不多.ps:每天上几分钟班,还有其他复杂好一点的,要么自己去搞定,要么换个工作.这个问题百度上都有。话说,要想爬虫玩牛逼,

文章采集系统(采集系统操作说明(傻瓜版)插件图(1))

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-10-21 18:08

采集系统操作说明(傻瓜版)

1.准备工作

1.1 安装 FireBug 浏览器插件

图片(1):FireBug插件安装

1.2 找到需要采集网站

的目标

使用以下教程示例:/main/zxnews.shtml 用于演示1.3 登录cms,进入需要的频道,进入采集的系统。

图片(2):采集系统入口

图片(3):成功进入采集系统

2.文章采集

2.1 进入节点管理页面,点击新建节点,正常选择节点类型文章

图(4):新建节点第一步

2.2命名节点,选择目标网站的页面编码属性,选择站点类型

图(5):新建节点第二步,基本信息设置

2.3 判断列表URL是批量生成还是手动指定;设置相关规则,本教程178斗神列表页面有分页,所以我们使用采集第1、2页的内容进行演示。如下图

图片(6):创建新节点的步骤3,列出URL获取规则

图片(7):创建新节点的步骤3,列出URL获取规则(通配后测试内容的显示)

2.4 使用之前安装的Firbug工具(F12调出工具),选择要采集的内容范围,设置采集列表区域和采集 列表信息 复制该区域对应的代码并粘贴到采集器。

图片(8):第4步新建节点,列出URL匹配规则(采集列表区域选择)

图片(8):创建新节点的第4步,列出URL匹配规则(采集复制列表区域对应的代码)

图片(9):第4步新建节点,列出URL匹配规则(粘贴到采集系统,删除红线代码)

图(10):第4步新建节点,列出URL匹配规则(红线代码删除后)

图(11):第四步新建节点,列出URL匹配规则(采集信息区选择)

图(12):创建新节点的第4步,列出URL匹配规则(采集信息区对应的代码拷贝)

图(13):第四步新建节点,列出URL匹配规则(粘贴到采集系统,删除相关代码)

图(14):第四步新建节点,列出URL匹配规则(删除后点击保存预览)

图片(15):采集列表网址预览(如果规则正确,可以显示以上列表,点击进入下一步)

图片(16):采集文章最终页面的内容(选择页面的方法和之前一样)

图片(17):采集文章最终页面内容(粘贴分页代码,删除多余部分,删除方法同上)

图片(18):采集文章终极页面内容(设置标题和正文规则)

图片(19):采集文章最终页面内容预览(如果没有问题,可以正常预览结果)

3.备注

3.1 使用从firebug复制的代码,需要删除html body部分。3.2采集 规则设置过程需要耐心和调试。如果你有任何问题,你可以 RTX 碧松 查看全部

文章采集系统(采集系统操作说明(傻瓜版)插件图(1))

采集系统操作说明(傻瓜版)

1.准备工作

1.1 安装 FireBug 浏览器插件

图片(1):FireBug插件安装

1.2 找到需要采集网站

的目标

使用以下教程示例:/main/zxnews.shtml 用于演示1.3 登录cms,进入需要的频道,进入采集的系统。

图片(2):采集系统入口

图片(3):成功进入采集系统

2.文章采集

2.1 进入节点管理页面,点击新建节点,正常选择节点类型文章

图(4):新建节点第一步

2.2命名节点,选择目标网站的页面编码属性,选择站点类型

图(5):新建节点第二步,基本信息设置

2.3 判断列表URL是批量生成还是手动指定;设置相关规则,本教程178斗神列表页面有分页,所以我们使用采集第1、2页的内容进行演示。如下图

图片(6):创建新节点的步骤3,列出URL获取规则

图片(7):创建新节点的步骤3,列出URL获取规则(通配后测试内容的显示)

2.4 使用之前安装的Firbug工具(F12调出工具),选择要采集的内容范围,设置采集列表区域和采集 列表信息 复制该区域对应的代码并粘贴到采集器。

图片(8):第4步新建节点,列出URL匹配规则(采集列表区域选择)

图片(8):创建新节点的第4步,列出URL匹配规则(采集复制列表区域对应的代码)

图片(9):第4步新建节点,列出URL匹配规则(粘贴到采集系统,删除红线代码)

图(10):第4步新建节点,列出URL匹配规则(红线代码删除后)

图(11):第四步新建节点,列出URL匹配规则(采集信息区选择)

图(12):创建新节点的第4步,列出URL匹配规则(采集信息区对应的代码拷贝)

图(13):第四步新建节点,列出URL匹配规则(粘贴到采集系统,删除相关代码)

图(14):第四步新建节点,列出URL匹配规则(删除后点击保存预览)

图片(15):采集列表网址预览(如果规则正确,可以显示以上列表,点击进入下一步)

图片(16):采集文章最终页面的内容(选择页面的方法和之前一样)

图片(17):采集文章最终页面内容(粘贴分页代码,删除多余部分,删除方法同上)

图片(18):采集文章终极页面内容(设置标题和正文规则)

图片(19):采集文章最终页面内容预览(如果没有问题,可以正常预览结果)

3.备注

3.1 使用从firebug复制的代码,需要删除html body部分。3.2采集 规则设置过程需要耐心和调试。如果你有任何问题,你可以 RTX 碧松

文章采集系统(文章采集系统实现方案主要解决三个问题(聚合组合))

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-10-17 19:04

文章采集系统实现方案主要解决三个问题:

一、聚合数据源及处理;

二、采集过程分析;

三、维度权重化更新(聚合组合)实现思路:

一、聚合数据源及处理。聚合数据源主要定义两个基本类,第一个是采集网站数据,为scrapy中的get请求,第二个是文本网站模板类,为post请求。处理环节主要是归档处理。归档主要有两种方法,一是用python自带的pandas,然后根据http请求来获取,或者是通过存储系统,如db来存储。二是使用scrapy自带的beautifulsoup库,然后对文本数据进行beautifulsoup的处理。

二、采集过程分析采集流程一般分为:数据采集、数据存储、数据分析三个过程,文章采集流程一般有4个阶段,ps阶段数据转化、每日传文章经过每个数据源处理,每个数据源处理完成后进入到循环滚动页面,以dataframe的形式传给spider进行分析、处理。

三、维度权重化更新(聚合组合)

1、网页整体维度权重化组合进行更新,生成指标体系,指标体系中,权重设置各个属性,时间、点击量、转发量、阅读量、文章发布日期等。指标属性采用字典格式进行字段定义。

2、根据指标体系,进行网页内容爬取、再将爬取结果存储,最后对每篇文章进行监控。

3、爬取结果存储利用mysql数据库进行存储,有条件的可以采用elasticsearch或solr,大型网站应用有采用mongodb,小型网站一般采用sharding-jdbc或sharding-edm或httplib或sharding-edj这些都是聚合组合,包括但不限于《scrapy爬虫三部曲之聚合组合》:对于爬取数据维度:可设置为daily/time/minute/hour/second这几个主要时间维度;对于数据来源维度:可设置为“/”"?"等字符串前缀维度;对于爬取文章页数量,可设置为一次性、连续型、定时型三种。

对于我们开发常用的实现方式,主要有基于python对scrapy进行封装或者自己写爬虫程序对scrapy的封装;基于scrapy自带的框架提供的接口;模仿scrapy对于spider中爬取部分,实现一个简单的“爬虫平台”。

1、文章描述层直接生成指标框架download函数传入指标名和值对,在自定义回调函数内可以用到return方法,定义返回值,返回格式为window参数表示返回到page页面,

2、分析层可以直接通过一个小demo来体会工作流程。第一步就是读取网页网址,获取e001d92-xxxx-yy-zjz-hd077这张表格,e001d92是从头到尾,e001d92-xxxx-yy-zjz-hd077是经过分割,从左到右来获取,cmp标识从第几行第几列读取,pixel可以定义mode,当。 查看全部

文章采集系统(文章采集系统实现方案主要解决三个问题(聚合组合))

文章采集系统实现方案主要解决三个问题:

一、聚合数据源及处理;

二、采集过程分析;

三、维度权重化更新(聚合组合)实现思路:

一、聚合数据源及处理。聚合数据源主要定义两个基本类,第一个是采集网站数据,为scrapy中的get请求,第二个是文本网站模板类,为post请求。处理环节主要是归档处理。归档主要有两种方法,一是用python自带的pandas,然后根据http请求来获取,或者是通过存储系统,如db来存储。二是使用scrapy自带的beautifulsoup库,然后对文本数据进行beautifulsoup的处理。

二、采集过程分析采集流程一般分为:数据采集、数据存储、数据分析三个过程,文章采集流程一般有4个阶段,ps阶段数据转化、每日传文章经过每个数据源处理,每个数据源处理完成后进入到循环滚动页面,以dataframe的形式传给spider进行分析、处理。

三、维度权重化更新(聚合组合)

1、网页整体维度权重化组合进行更新,生成指标体系,指标体系中,权重设置各个属性,时间、点击量、转发量、阅读量、文章发布日期等。指标属性采用字典格式进行字段定义。

2、根据指标体系,进行网页内容爬取、再将爬取结果存储,最后对每篇文章进行监控。

3、爬取结果存储利用mysql数据库进行存储,有条件的可以采用elasticsearch或solr,大型网站应用有采用mongodb,小型网站一般采用sharding-jdbc或sharding-edm或httplib或sharding-edj这些都是聚合组合,包括但不限于《scrapy爬虫三部曲之聚合组合》:对于爬取数据维度:可设置为daily/time/minute/hour/second这几个主要时间维度;对于数据来源维度:可设置为“/”"?"等字符串前缀维度;对于爬取文章页数量,可设置为一次性、连续型、定时型三种。

对于我们开发常用的实现方式,主要有基于python对scrapy进行封装或者自己写爬虫程序对scrapy的封装;基于scrapy自带的框架提供的接口;模仿scrapy对于spider中爬取部分,实现一个简单的“爬虫平台”。

1、文章描述层直接生成指标框架download函数传入指标名和值对,在自定义回调函数内可以用到return方法,定义返回值,返回格式为window参数表示返回到page页面,

2、分析层可以直接通过一个小demo来体会工作流程。第一步就是读取网页网址,获取e001d92-xxxx-yy-zjz-hd077这张表格,e001d92是从头到尾,e001d92-xxxx-yy-zjz-hd077是经过分割,从左到右来获取,cmp标识从第几行第几列读取,pixel可以定义mode,当。

文章采集系统(文章采集系统和国内nodejs方面有很大的区别(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-10-13 16:04

文章采集系统和国内nodejs方面有很大的区别,我推荐上一些有价值的文章:《产品定位如何推广nodejs?》、《国内nodejs产品解析(上)》、《产品定位如何推广nodejs?》、《产品定位如何推广nodejs?》、《产品定位如何推广nodejs?》、《产品定位如何推广nodejs?》、《跨越鸿沟,无需改造就可复制facebook》、《一套系统解决两条路径——framework+api模式和nodejs+flex+express+spring的信息流组合》、《一个产品方案从设计到落地的全套流程》、《mongodb从无到有的第一次性能调优》、《解构&重构》、《choose3:单体应用还是小而美的独立应用》、《解构&重构:从纯js到通用后端?》、《解构&重构:从纯js到通用后端?》、《做一套产品设计、架构和创新系统解决方案》、《mongodb从无到有的第一次性能调优》、《解构&重构:从纯js到通用后端?》、《是all-inone还是all-less?让es6走上中心路线》、《是all-inone还是all-less?让es6走上中心路线》、《o2o转型vc策略探索》、《写给程序员看的图形化工具和图表绘制教程》、《云产品功能设计》、《nodejs开发效率提升方案十一五研究报告》、《nodejs开发效率提升方案十一五研究报告》、《《无线nodejs产品方案》》、《初探flash-5api性能优化》、《nodejs结构性问题的数据风险分析》、《初探flash-5api性能优化》、《nodejs2。

0发布在即:apiwait相关框架方案展望》、《《restful服务端应用架构设计》》、《cloudnativeinfluxexpress’sdistinctanddevelopment》、《futurecore诞生记之一:字符串联》、《解构&重构》、《nodejs一键实现native方案》、《futurecore诞生记之一:字符串联》、《nodejs一键实现native方案》、《nodejs一键实现native方案》、《fetch+express的api持久化扩展与架构》、《nodejs使用request。

postmessage()和websocket传输restfulapi》、《一种深度使用jquery的跨语言nodejs微服务架构》、《angularjs三代开发系统的方案方法论探索》、《移动端nodejs解决方案集锦》、《解构&重构:从上层nodejs技术支持到底层万维网级别framework解决方案》、《解构&重构:从深度介绍nodejs优势到架构简易示例服务端架构》、《nodejs高可用设计解析》、《解构&重构:从多方案解决一个大容量场景问题到落地易扩展落地容灾》、《工程师转型初期如何做跨领域人才培养方案设计》、《更多知识我们总结在了专栏——高性能场景下的javascript应用架构》《更多知识我们总结在了专栏——高性能场。 查看全部

文章采集系统(文章采集系统和国内nodejs方面有很大的区别(组图))

文章采集系统和国内nodejs方面有很大的区别,我推荐上一些有价值的文章:《产品定位如何推广nodejs?》、《国内nodejs产品解析(上)》、《产品定位如何推广nodejs?》、《产品定位如何推广nodejs?》、《产品定位如何推广nodejs?》、《产品定位如何推广nodejs?》、《跨越鸿沟,无需改造就可复制facebook》、《一套系统解决两条路径——framework+api模式和nodejs+flex+express+spring的信息流组合》、《一个产品方案从设计到落地的全套流程》、《mongodb从无到有的第一次性能调优》、《解构&重构》、《choose3:单体应用还是小而美的独立应用》、《解构&重构:从纯js到通用后端?》、《解构&重构:从纯js到通用后端?》、《做一套产品设计、架构和创新系统解决方案》、《mongodb从无到有的第一次性能调优》、《解构&重构:从纯js到通用后端?》、《是all-inone还是all-less?让es6走上中心路线》、《是all-inone还是all-less?让es6走上中心路线》、《o2o转型vc策略探索》、《写给程序员看的图形化工具和图表绘制教程》、《云产品功能设计》、《nodejs开发效率提升方案十一五研究报告》、《nodejs开发效率提升方案十一五研究报告》、《《无线nodejs产品方案》》、《初探flash-5api性能优化》、《nodejs结构性问题的数据风险分析》、《初探flash-5api性能优化》、《nodejs2。

0发布在即:apiwait相关框架方案展望》、《《restful服务端应用架构设计》》、《cloudnativeinfluxexpress’sdistinctanddevelopment》、《futurecore诞生记之一:字符串联》、《解构&重构》、《nodejs一键实现native方案》、《futurecore诞生记之一:字符串联》、《nodejs一键实现native方案》、《nodejs一键实现native方案》、《fetch+express的api持久化扩展与架构》、《nodejs使用request。

postmessage()和websocket传输restfulapi》、《一种深度使用jquery的跨语言nodejs微服务架构》、《angularjs三代开发系统的方案方法论探索》、《移动端nodejs解决方案集锦》、《解构&重构:从上层nodejs技术支持到底层万维网级别framework解决方案》、《解构&重构:从深度介绍nodejs优势到架构简易示例服务端架构》、《nodejs高可用设计解析》、《解构&重构:从多方案解决一个大容量场景问题到落地易扩展落地容灾》、《工程师转型初期如何做跨领域人才培养方案设计》、《更多知识我们总结在了专栏——高性能场景下的javascript应用架构》《更多知识我们总结在了专栏——高性能场。

文章采集系统(文章采集系统支持识别、文本翻译等功能方法汇总)

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-10-12 07:00

文章采集系统支持识别、文本识别、图片识别、微信爬虫、api对接、图片处理、文本翻译等功能。

1)识别:@coder支持阿里云、华为云、腾讯云、百度云等云服务器,支持voip通话识别,要求配置有ip,点击添加按钮,即可跳转到对应平台。

2)文本识别:@helper文本识别的具体算法和实现比较多,本文采用比较常见的textcnn方法。在训练数据使用问题上,考虑简单,均使用了kaggle/mini-daily下的数据集(frequency+category)。识别速度方面,阿里云比云外便宜不少,云外稍微贵一些,也比较安全,不会丢失用户。

3)微信爬虫:@jh获取附近新用户,抓取微信公众号的文章评论及点赞的数据。方法:微信公众号中可见的微信公众号文章信息皆可抓取,整理成excel,然后转化为exceltxt文件。exceltxt文件中每一行代表一条数据。redis的excel数据均可以容纳所有的微信公众号文章信息,整理好转化成excel数据,可直接到公众号自动回复中,使用submit方法发送给redis服务器。

方法如下:当用户关注redis服务器后,创建一个连接,把文章信息请求给redis服务器,redis服务器返回schema信息,然后使用query方法去解析这个schema信息。获取微信公众号文章的文章名、题目、标题信息解析微信公众号文章文章名、题目、标题信息excel方法如下:先提取name字段值,然后使用user_id和people_id字段值解析出文章信息的信息如下:解析解析出的文章信息内容_note_description.enclave.header={'location':'','host':'','path':'','type':'format','user_agent':'mozilla/5.0(windowsnt6.1;wow6。

4)applewebkit/537。36(khtml,likegecko)chrome/51。3083。110safari/537。36','subtitle':'','breakline':'','label':'','default_encoding':'utf-8','author':'','editor':'','errors':'','exit':'','text':'','description':'','content':'','text_list':'','content_comment':'','image_info':'','image_title':'','image_post':'','image_link':'','image_title':'','image':'','image_content':'','image':'','tag':'','content':'','source':'','user_id':'','email'。 查看全部

文章采集系统(文章采集系统支持识别、文本翻译等功能方法汇总)

文章采集系统支持识别、文本识别、图片识别、微信爬虫、api对接、图片处理、文本翻译等功能。

1)识别:@coder支持阿里云、华为云、腾讯云、百度云等云服务器,支持voip通话识别,要求配置有ip,点击添加按钮,即可跳转到对应平台。

2)文本识别:@helper文本识别的具体算法和实现比较多,本文采用比较常见的textcnn方法。在训练数据使用问题上,考虑简单,均使用了kaggle/mini-daily下的数据集(frequency+category)。识别速度方面,阿里云比云外便宜不少,云外稍微贵一些,也比较安全,不会丢失用户。

3)微信爬虫:@jh获取附近新用户,抓取微信公众号的文章评论及点赞的数据。方法:微信公众号中可见的微信公众号文章信息皆可抓取,整理成excel,然后转化为exceltxt文件。exceltxt文件中每一行代表一条数据。redis的excel数据均可以容纳所有的微信公众号文章信息,整理好转化成excel数据,可直接到公众号自动回复中,使用submit方法发送给redis服务器。

方法如下:当用户关注redis服务器后,创建一个连接,把文章信息请求给redis服务器,redis服务器返回schema信息,然后使用query方法去解析这个schema信息。获取微信公众号文章的文章名、题目、标题信息解析微信公众号文章文章名、题目、标题信息excel方法如下:先提取name字段值,然后使用user_id和people_id字段值解析出文章信息的信息如下:解析解析出的文章信息内容_note_description.enclave.header={'location':'','host':'','path':'','type':'format','user_agent':'mozilla/5.0(windowsnt6.1;wow6。

4)applewebkit/537。36(khtml,likegecko)chrome/51。3083。110safari/537。36','subtitle':'','breakline':'','label':'','default_encoding':'utf-8','author':'','editor':'','errors':'','exit':'','text':'','description':'','content':'','text_list':'','content_comment':'','image_info':'','image_title':'','image_post':'','image_link':'','image_title':'','image':'','image_content':'','image':'','tag':'','content':'','source':'','user_id':'','email'。

文章采集系统(文章采集系统整体架构(一)获取微信文章地址)

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-10-11 15:25

文章采集系统整体架构文章采集系统分为外部采集和内部采集,采集方式主要有手动采集和自动化采集;手动采集方式通过浏览器地址采集;自动化采集方式:文章采集系统采用封装了传统的excel采集代码、c++开发的文章采集系统采集,采集方式如下。文章采集系统整体架构如下图1所示。文章采集系统将自动获取微信文章地址进行抓取;微信公众号文章以自定义菜单模式对外提供,如下图2所示。

相应的地址抓取方式如下。murl为采集系统自定义域名,当然如果外部也可以对接,自定义域名为,wos相应的域名为,wos为微信公众号文章地址。但是可能登录微信公众号不可用,需要将此域名禁止访问;设置页面地址之后需要对此路径进行解析,进行页面首页抓取;第1步:浏览器输入微信公众号文章网址,实现获取ip地址;该页面地址通过微信地址_wechat公众号,获取微信号ip地址后即可获取微信号和文章url,将其保存于excel表格,保存地址需要和本机端设置和保存到同一网络;这里设置了服务器端ip,比如目标网络上有5台公共服务器,存在共同的端口wechat_netserver,会被捕获为同一端口,浏览器访问这个端口wechat_netserver获取或者获取时,发生xmlhttprequest;这里存在一个端口favicon_info:1默认端口开放8080,如果端口不存在需要通过修改ip,0,1-authorized_profile选择端口;2另外需要修改view_pages,直接navigate会访问本机端口,把page设置为本机端口号,且为utf-8;然后重启本机端口即可;这样就实现了本机端口为wechat_netserver;端口号将来需要给本机加入ip地址,端口号是否对外公开给外部应用并不是必须,主要是有一个对外公开端口,但是不得不说现在大多数网站外部访问都不太稳定,经常会出现服务器死机等问题,为了控制本机端口映射的稳定程度,如果公众号外部是用电脑或者手机,则其端口将不公开给外部应用;如果此端口是完全对外公开,则可以将其端口公开,让外部服务器接受自己的网络请求;因此,目前外部应用访问本机端口wechat_netserver地址时如果采取的是http协议则内容将会被一同发送到外部服务器;wos,除了用于区分公众号注册时,还可以用于区分公众号授权时获取微信号信息和自动注册公众号时获取公众号信息;wos接受微信接口请求,并且进行解析返回数据的各种操作;当文章接口上线后,wos服务器端同步接收文章接口返回的数据,从而完成抓取;4第2步:手动采集文章信息获取公众号文章url从上图可以看出,文章信息信息获取方式包括两种:1手动获取。 查看全部

文章采集系统(文章采集系统整体架构(一)获取微信文章地址)

文章采集系统整体架构文章采集系统分为外部采集和内部采集,采集方式主要有手动采集和自动化采集;手动采集方式通过浏览器地址采集;自动化采集方式:文章采集系统采用封装了传统的excel采集代码、c++开发的文章采集系统采集,采集方式如下。文章采集系统整体架构如下图1所示。文章采集系统将自动获取微信文章地址进行抓取;微信公众号文章以自定义菜单模式对外提供,如下图2所示。

相应的地址抓取方式如下。murl为采集系统自定义域名,当然如果外部也可以对接,自定义域名为,wos相应的域名为,wos为微信公众号文章地址。但是可能登录微信公众号不可用,需要将此域名禁止访问;设置页面地址之后需要对此路径进行解析,进行页面首页抓取;第1步:浏览器输入微信公众号文章网址,实现获取ip地址;该页面地址通过微信地址_wechat公众号,获取微信号ip地址后即可获取微信号和文章url,将其保存于excel表格,保存地址需要和本机端设置和保存到同一网络;这里设置了服务器端ip,比如目标网络上有5台公共服务器,存在共同的端口wechat_netserver,会被捕获为同一端口,浏览器访问这个端口wechat_netserver获取或者获取时,发生xmlhttprequest;这里存在一个端口favicon_info:1默认端口开放8080,如果端口不存在需要通过修改ip,0,1-authorized_profile选择端口;2另外需要修改view_pages,直接navigate会访问本机端口,把page设置为本机端口号,且为utf-8;然后重启本机端口即可;这样就实现了本机端口为wechat_netserver;端口号将来需要给本机加入ip地址,端口号是否对外公开给外部应用并不是必须,主要是有一个对外公开端口,但是不得不说现在大多数网站外部访问都不太稳定,经常会出现服务器死机等问题,为了控制本机端口映射的稳定程度,如果公众号外部是用电脑或者手机,则其端口将不公开给外部应用;如果此端口是完全对外公开,则可以将其端口公开,让外部服务器接受自己的网络请求;因此,目前外部应用访问本机端口wechat_netserver地址时如果采取的是http协议则内容将会被一同发送到外部服务器;wos,除了用于区分公众号注册时,还可以用于区分公众号授权时获取微信号信息和自动注册公众号时获取公众号信息;wos接受微信接口请求,并且进行解析返回数据的各种操作;当文章接口上线后,wos服务器端同步接收文章接口返回的数据,从而完成抓取;4第2步:手动采集文章信息获取公众号文章url从上图可以看出,文章信息信息获取方式包括两种:1手动获取。

文章采集系统(商业版提醒您:请勿线下交易,谨防上当受骗!(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-10-02 13:13

IT88168提醒您:请勿线下交易,谨防上当受骗!

系统部署无差错,采集规则,可以自己写也可以找人写

演示环境可用于测试采集的规则,源码与演示环境一致

比较热门的商业版

手机版

支持手机版和PC跳转手机

模板

PC和手机模板各有2套,后续会继续制作

网址格式

可定制各种url样式

采集

支持自定义采集目标,采集章节内容

章节阅读

站内阅读大大增加PV(收入靠高PV)

站点地图

站点地图,在百度站点搜索xml

PHP7

完美支持

搜索功能

有自己的搜索功能

HTML

首页/列表页/信息页/章节页可以是静态HTML

标签标签

有

技术援助

及时有效的一对一技术支持

盈利预期

1000IP预期收益30元

后续更新

是的,并采用用户意见进行开发

伪静态配置见压缩包中的txt文件,不同环境有不同的配置说明(内置.htacess文件重新优化兼容性,解决了可能出现的“No input file specified.”问题在 apache+nts 模式下)

安装步骤:

1.解压文件上传到对应目录等

2.网站 必须配置伪静态(参考上一步的配置)才能正常安装使用(第一次访问首页会自动进入安装页面,或手动输入域名.com/install)

3.同意使用协议进入下一步检查目录权限

4. 测试通过后填写一般数据库配置项,填写正确即安装成功,安装成功后会自动进入后台页面域名.com/admin,填写在后台管理员和安装时输入的密码登录

5.在后台文章列表页面,可以手动采集文章,批量处理采集文章数据。初次安装后,建议采集一些数据填写网站的内容。网站 运行过程中会自动执行采集操作(前台访问触发,蜘蛛也可以触发采集),无需人工干预

环境要求:PHP5.4 及以上,具有伪静态功能。推荐配置,php7.1,mysql5.6+

主机要求:IIS/APACHE/NGINX,虚拟主机/VPS/服务器/云服务器。推荐Linux系统,可以使用apache/nginx

硬件要求:CPU/内存/硬盘/宽带大小不做要求,但配置越高,采集效率会更好!

其他要求:如果采集目标服务器在国内,而你的主机在国外,会造成采集效率低下。您应该尝试在 采集 的同一区域中选择 网站。美国服务器应该选择机房在美国的小说站点,国内服务器应该选择国内站点,尽可能提高网站的速度。

更新提醒:

1.添加关键词功能,可批量添加,可定制tdk

2.增加广告位管理功能

3.增加百度站点搜索功能,修复百度结构化数据覆盖错误的bug

4.新增图片懒加载功能,可PC开启或全站开启或关闭

5.新增黑名单和IP黑名单功能

6.添加作者功能

7.增加通过ID指定节点的功能采集(范围或指定)

8.友情链接已修改,允许同名关键词

9.修复编辑章节内容后出现乱码问题

10.添加原创功能

11.新增节点批量转换小说到新节点的功能,并指定小说转换节点的功能

12. 增加百度主动推送功能

13. 新增singlebiquge模板,适合推广单篇小说

14.重选功能,如果文中出现关键词(可以指定关键词),下次再从源站读取采集@ >

1 如果5.章节url与缓存中的url不一致,重新采集内容,解决章节不对应或源站修改删除重复章节的问题节点

16.增加简繁切换功能,并记录cookies,自动切换页面

17.修复专栏页面自定义TDK无效问题,新增小说页面单个小说自定义TDK

18. 更换加密方案,新版本使用全新授权文件,老版本不受影响。后台授权检测间隔调整为24小时,减少授权服务器对用户后台的影响网站

19. 添加节点库定义。已经入库的小说遇到其他节点也会进入节点库,方便小说切换到其他节点。这意味着,如果您的节点数据库在新节点上没有小说的记录,则小说无法切换到指定节点。

20. 功能模块拆分,方便后续增强

21.修复站点地图不显示时间的bug,增加对google和https的兼容性

22. 其他大量功能优化,不再一一赘述。

演示库

交易流程

运输方式

1、自动:标有自动发货的商品,拍下后会自动收到卖家发来的商品获取(下载)链接;

2、手动:对于没有标注自动发货的产品,卖家会在拍照后收到邮件或短信提醒。您也可以通过QQ或订单中的电话联系对方。

交易周期

1、 源码默认交易周期:3天,买家有权延长交易周期4天;

2、 如果双方在上述交易期限内仍不能完成交易,任何一方均可提出延长期限(1~60天)的请求,对方同意联系IT88168客服延长。

退款说明

1、描述:源代码描述(包括标题)与实际源代码不一致(例如:描述PHP实际上是ASP,描述的功能实际上缺失,版本不匹配等。 );

2、Demonstration:当有demo站点时,源代码与实际源代码的一致性小于95%(除了同样重要的声明“不保证完全相同,有更改的可能” "在说明中);

3、发货:如果卖家在发货前已申请退款,则手动发货源代码;

4、安装:安装服务源代码免费提供但卖家不履行;

5、 费用:收取额外费用(说明中有重要说明或交易前双方已约定的除外);

6、其他:比如硬性和常规的质量问题。

注:经核实符合以上任何一项后,支持退款,除非卖家主动解决问题。

预防措施

1、IT88168将对交易双方的交易过程和交易商品的快照进行永久存档,确保交易的真实性、有效性和安全性!

2、IT88168无法保证商家在类似交易后的承诺,如“永久更新套餐”、“永久技术支持”等,请买家自行识别;

3、 源码说明中,有网站演示和图片演示,如果单口表演与图片表演不一致,以默认图片表演为准判决(特别声明或约定除外);

4、 在没有“无合理退款依据”的前提下,产品出现“一经售出,不支持退款”等类似声明,视为无效声明;

5、拍照前,双方在QQ上约定的交易内容也可以作为争议判断的依据(约定与描述冲突时,以约定为准);

5、由于聊天记录可以作为判断纠纷的依据,所以双方在联系时,只与对方在IT88168上留下的QQ和手机号码进行交流,以防对方不认识自己-承诺。

7、虽然发生交易纠纷的概率很小,但是聊天记录、手机短信等重要信息必须保留,防止IT88168介入,快速处理纠纷。 查看全部

文章采集系统(商业版提醒您:请勿线下交易,谨防上当受骗!(组图))

IT88168提醒您:请勿线下交易,谨防上当受骗!

系统部署无差错,采集规则,可以自己写也可以找人写

演示环境可用于测试采集的规则,源码与演示环境一致

比较热门的商业版

手机版

支持手机版和PC跳转手机

模板

PC和手机模板各有2套,后续会继续制作

网址格式

可定制各种url样式

采集

支持自定义采集目标,采集章节内容

章节阅读

站内阅读大大增加PV(收入靠高PV)

站点地图

站点地图,在百度站点搜索xml

PHP7

完美支持

搜索功能

有自己的搜索功能

HTML

首页/列表页/信息页/章节页可以是静态HTML

标签标签

有

技术援助

及时有效的一对一技术支持

盈利预期

1000IP预期收益30元

后续更新

是的,并采用用户意见进行开发

伪静态配置见压缩包中的txt文件,不同环境有不同的配置说明(内置.htacess文件重新优化兼容性,解决了可能出现的“No input file specified.”问题在 apache+nts 模式下)

安装步骤:

1.解压文件上传到对应目录等

2.网站 必须配置伪静态(参考上一步的配置)才能正常安装使用(第一次访问首页会自动进入安装页面,或手动输入域名.com/install)

3.同意使用协议进入下一步检查目录权限

4. 测试通过后填写一般数据库配置项,填写正确即安装成功,安装成功后会自动进入后台页面域名.com/admin,填写在后台管理员和安装时输入的密码登录

5.在后台文章列表页面,可以手动采集文章,批量处理采集文章数据。初次安装后,建议采集一些数据填写网站的内容。网站 运行过程中会自动执行采集操作(前台访问触发,蜘蛛也可以触发采集),无需人工干预

环境要求:PHP5.4 及以上,具有伪静态功能。推荐配置,php7.1,mysql5.6+

主机要求:IIS/APACHE/NGINX,虚拟主机/VPS/服务器/云服务器。推荐Linux系统,可以使用apache/nginx

硬件要求:CPU/内存/硬盘/宽带大小不做要求,但配置越高,采集效率会更好!

其他要求:如果采集目标服务器在国内,而你的主机在国外,会造成采集效率低下。您应该尝试在 采集 的同一区域中选择 网站。美国服务器应该选择机房在美国的小说站点,国内服务器应该选择国内站点,尽可能提高网站的速度。

更新提醒:

1.添加关键词功能,可批量添加,可定制tdk

2.增加广告位管理功能

3.增加百度站点搜索功能,修复百度结构化数据覆盖错误的bug

4.新增图片懒加载功能,可PC开启或全站开启或关闭

5.新增黑名单和IP黑名单功能

6.添加作者功能

7.增加通过ID指定节点的功能采集(范围或指定)

8.友情链接已修改,允许同名关键词

9.修复编辑章节内容后出现乱码问题

10.添加原创功能

11.新增节点批量转换小说到新节点的功能,并指定小说转换节点的功能

12. 增加百度主动推送功能

13. 新增singlebiquge模板,适合推广单篇小说

14.重选功能,如果文中出现关键词(可以指定关键词),下次再从源站读取采集@ >

1 如果5.章节url与缓存中的url不一致,重新采集内容,解决章节不对应或源站修改删除重复章节的问题节点

16.增加简繁切换功能,并记录cookies,自动切换页面

17.修复专栏页面自定义TDK无效问题,新增小说页面单个小说自定义TDK

18. 更换加密方案,新版本使用全新授权文件,老版本不受影响。后台授权检测间隔调整为24小时,减少授权服务器对用户后台的影响网站

19. 添加节点库定义。已经入库的小说遇到其他节点也会进入节点库,方便小说切换到其他节点。这意味着,如果您的节点数据库在新节点上没有小说的记录,则小说无法切换到指定节点。

20. 功能模块拆分,方便后续增强

21.修复站点地图不显示时间的bug,增加对google和https的兼容性

22. 其他大量功能优化,不再一一赘述。

演示库

交易流程

运输方式

1、自动:标有自动发货的商品,拍下后会自动收到卖家发来的商品获取(下载)链接;

2、手动:对于没有标注自动发货的产品,卖家会在拍照后收到邮件或短信提醒。您也可以通过QQ或订单中的电话联系对方。

交易周期

1、 源码默认交易周期:3天,买家有权延长交易周期4天;

2、 如果双方在上述交易期限内仍不能完成交易,任何一方均可提出延长期限(1~60天)的请求,对方同意联系IT88168客服延长。

退款说明

1、描述:源代码描述(包括标题)与实际源代码不一致(例如:描述PHP实际上是ASP,描述的功能实际上缺失,版本不匹配等。 );

2、Demonstration:当有demo站点时,源代码与实际源代码的一致性小于95%(除了同样重要的声明“不保证完全相同,有更改的可能” "在说明中);

3、发货:如果卖家在发货前已申请退款,则手动发货源代码;

4、安装:安装服务源代码免费提供但卖家不履行;

5、 费用:收取额外费用(说明中有重要说明或交易前双方已约定的除外);

6、其他:比如硬性和常规的质量问题。

注:经核实符合以上任何一项后,支持退款,除非卖家主动解决问题。

预防措施

1、IT88168将对交易双方的交易过程和交易商品的快照进行永久存档,确保交易的真实性、有效性和安全性!

2、IT88168无法保证商家在类似交易后的承诺,如“永久更新套餐”、“永久技术支持”等,请买家自行识别;

3、 源码说明中,有网站演示和图片演示,如果单口表演与图片表演不一致,以默认图片表演为准判决(特别声明或约定除外);

4、 在没有“无合理退款依据”的前提下,产品出现“一经售出,不支持退款”等类似声明,视为无效声明;

5、拍照前,双方在QQ上约定的交易内容也可以作为争议判断的依据(约定与描述冲突时,以约定为准);

5、由于聊天记录可以作为判断纠纷的依据,所以双方在联系时,只与对方在IT88168上留下的QQ和手机号码进行交流,以防对方不认识自己-承诺。

7、虽然发生交易纠纷的概率很小,但是聊天记录、手机短信等重要信息必须保留,防止IT88168介入,快速处理纠纷。

文章采集系统( DiY论坛门户+论坛采集+文章系统+直观设计,只有500!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2021-10-02 07:06

DiY论坛门户+论坛采集+文章系统+直观设计,只有500!)

6月1日500KB=论坛门户+论坛采集+文章系统+文章采集+Intuitive Design=DiY-Page 5.1. 3

什么是 DiY-Page?

DiY-Page = 论坛门户+论坛采集 + 文章系统+ 文章采集 + 直观设计,仅500KB!

有论坛可以建网站,没有论坛也可以建网站。海量内容可以立即导入。

演示地址

前台演示:

后台演示(用户名admin密码root):

详细介绍

如果您已经有论坛,请安装 DiY-Page 到——

1、让你用论坛内容快速搭建门户类型网站

2、论坛采集的功能为您提供更丰富的内容来源(支持指定发帖成员和附加发帖)

3、搜索引擎数量大幅增加收录论坛内容

注1:支持的论坛包括Discuz 6.1 or 6.0 or 5.5, PHPWind 6.3 or 6.0 or 5.3

注2:官网收录 demo(只有六千多帖子)

%

%

如果你没有论坛,也可以安装DiY-Page——

1、基于文章系统快速搭建简单的门户类型网站

2、用采集网站快速丰富内容

3、网站快速成为海量搜索引擎收录为您带来流量和价值

还 -

仅500KB,不修改论坛程序和数据表,安装/删除不影响论坛;独创的“Design Window (TM)”可以在后台直观地修改所有页面布局(DIV+CSS/表格);支持无限主题分页功能,可实现二级分页和N级分页

获奖作品——

DiY-Page荣获第22届全国青少年科技创新大赛(计算机科学一))金奖、第八届高士奇科普奖-国家青少年科技发明奖、第四届中国青少年科技创新奖创新奖(共青团中央),还入选“第22届全国青年科技创新大赛获奖作品集”收录(本书在全国新华书店有售),作者文牧原已被中国人民大学录取,并获得北京独立大学录取资格(均可在教育部网站查询)

软件下载

这是简繁GB/BIG5/UTF8通用安装包,默认为简体中文GB编码,繁体或UTF8用户可到后台“修改设置”更改

免费下载地址:

安装、升级、卸载方法

请参考下载的安装包中的“手册”,里面有详细的介绍

视频教程

演示从安装到使用的基本流程,一目了然!

在线观看(左栏为点播菜单):

群号:10877600

欢迎所有DiY-Page新人加入,群内有经验的用户将帮助您快速上手!

加入时请附上原因“DiY-Page user”,否则申请将不被批准

欢迎购买

用户可以无限期试用该软件,不受功能限制。

如果您感到满意,欢迎购买许可并成为我们的正式用户。凭学生证可享受大优惠。

购买后可在前台清除所有版权信息并帮助安装、调试、更改布局、编写采集规则等,终身免费升级。 查看全部

文章采集系统(

DiY论坛门户+论坛采集+文章系统+直观设计,只有500!)

6月1日500KB=论坛门户+论坛采集+文章系统+文章采集+Intuitive Design=DiY-Page 5.1. 3

什么是 DiY-Page?

DiY-Page = 论坛门户+论坛采集 + 文章系统+ 文章采集 + 直观设计,仅500KB!

有论坛可以建网站,没有论坛也可以建网站。海量内容可以立即导入。

演示地址

前台演示:

后台演示(用户名admin密码root):

详细介绍

如果您已经有论坛,请安装 DiY-Page 到——

1、让你用论坛内容快速搭建门户类型网站

2、论坛采集的功能为您提供更丰富的内容来源(支持指定发帖成员和附加发帖)

3、搜索引擎数量大幅增加收录论坛内容

注1:支持的论坛包括Discuz 6.1 or 6.0 or 5.5, PHPWind 6.3 or 6.0 or 5.3

注2:官网收录 demo(只有六千多帖子)

%

%

如果你没有论坛,也可以安装DiY-Page——

1、基于文章系统快速搭建简单的门户类型网站

2、用采集网站快速丰富内容

3、网站快速成为海量搜索引擎收录为您带来流量和价值

还 -

仅500KB,不修改论坛程序和数据表,安装/删除不影响论坛;独创的“Design Window (TM)”可以在后台直观地修改所有页面布局(DIV+CSS/表格);支持无限主题分页功能,可实现二级分页和N级分页

获奖作品——

DiY-Page荣获第22届全国青少年科技创新大赛(计算机科学一))金奖、第八届高士奇科普奖-国家青少年科技发明奖、第四届中国青少年科技创新奖创新奖(共青团中央),还入选“第22届全国青年科技创新大赛获奖作品集”收录(本书在全国新华书店有售),作者文牧原已被中国人民大学录取,并获得北京独立大学录取资格(均可在教育部网站查询)

软件下载

这是简繁GB/BIG5/UTF8通用安装包,默认为简体中文GB编码,繁体或UTF8用户可到后台“修改设置”更改

免费下载地址:

安装、升级、卸载方法

请参考下载的安装包中的“手册”,里面有详细的介绍

视频教程

演示从安装到使用的基本流程,一目了然!

在线观看(左栏为点播菜单):

群号:10877600

欢迎所有DiY-Page新人加入,群内有经验的用户将帮助您快速上手!

加入时请附上原因“DiY-Page user”,否则申请将不被批准

欢迎购买

用户可以无限期试用该软件,不受功能限制。

如果您感到满意,欢迎购买许可并成为我们的正式用户。凭学生证可享受大优惠。

购买后可在前台清除所有版权信息并帮助安装、调试、更改布局、编写采集规则等,终身免费升级。

文章采集系统(万能文章采集器的功能介绍什么是高精度正文识别识别算法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-09-27 11:11

万能文章采集器是一款方便易用的文章采集软件,功能强大,完全免费使用。软件操作简单,可准确提取网页正文部分并保存为文章,支持标签、链接、邮件等格式处理,只需几分钟即可采集 你想要 文章 中的任何一个。并且拥有独家首创的智能通用算法。只需输入关键字即可采集各种网页和新闻,也可以采集指定列表页(栏目页)文章,准确提取网页正文部分并保存它作为 文章 内容。同时还有插入关键词的功能,可以识别标签或标点的插入,并且可以识别英文空格的插入,还具有文章翻译的功能,即可以将文章从一种语言转换为英语或日语等另一种语言,以及然后从英文或者日文回中文,这是一个翻译周期,翻译周期可以设置重复多次。如果你对某个关键词文章感兴趣,想批量下载,可以使用这个完全免费的优采云Universal文章采集器,如Users有需要的欢迎下载!然后从英文或者日文回中文,这是一个翻译周期,翻译周期可以设置重复多次。如果你对某个关键词文章感兴趣,想批量下载,可以使用这个完全免费的优采云Universal文章采集器,如Users有需要的欢迎下载!然后从英文或者日文回中文,这是一个翻译周期,翻译周期可以设置重复多次。如果你对某个关键词文章感兴趣,想批量下载,可以使用这个完全免费的优采云Universal文章采集器,如Users有需要的欢迎下载!

软件特点

一、 依托优采云软件独有的通用文本识别智能算法,可实现任意网页文本的自动提取,准确率达95%以上。

二、只需输入关键词到采集到百度新闻和网页、搜狗新闻和网页、360新闻和网页、谷歌新闻和网页、必应新闻和网页、雅虎;可批量关键词全自动采集。

三、可以直接采集指定网站列列表下的所有文章,智能匹配,无需编写复杂规则。

四、文章翻译功能,可以将采集好文章翻译成英文再翻译回中文,实现翻译伪原创,支持谷歌和是道翻译.

五、史上最简单最智能文章采集器,支持全功能试用,一试就知道效果!

特征

什么是高精度文本识别算法

该算法由优采云自主研发。它可以从网页中提取正文部分,准确率通常可以达到95%。如果进一步设置最小字符数,采集的文章(正确性)的准确率可以达到99%。同时,文章标题也达到了99%的提取准确率。当然,当某些网页的布局格式混乱、不规则时,可能会降低准确性。

文本提取方式

文本提取算法有标准标签、严格标签和精确标签三种模式。在大多数情况下,标准模式和严格模式是相同的提取结果。以下是特殊情况:

标准模式:一般提取,大部分时候可以准确提取文本,但是一些特殊的页面会导致提取一些不必要的内容(但是这种模式可以更好的识别文章页面类似于百度的经验)

严格模式:顾名思义,比标准模式严格一点,在很大程度上可以避免提取不相关的内容作为正文,但是对于百度体验页等特殊的分段页面(不是一般

段落,但有多个独立的div段并带有格式),一般只能提取某一段落,而标准模式可以提取所有段落。

精确标签:不使用标准和严格模式时,可以精确指定目标正文的标签头。此模式仅适用于网络批处理。

所以可以根据实际情况切换模式。您可以使用本地批处理的读取网页正文功能来测试指定网页适合提取哪种模式。

采集 处理选项

采集 可以在翻译、过滤、搜索词的同时进行处理。对于那些已经采集好的文章,可以使用“本地批处理”。

翻译功能是将中文翻译成英文再翻译回中文,也产生了伪原创的效果。支持原创格式翻译,即不改变文章的原创标签结构和排版格式。

采集目标是网址

您可以在 URL 模板中插入 #URL#、#title# 以合并引用

分页采集和相对路径转换为绝对路径

勾选“Auto 采集 Paging”合并页面文章采集,编辑框设置为最大采集页数。建议设置一个有限值,比如10页,避免分页过多耗时采集,组合起来的文章体积庞大。如果需要采集所有页面,可以设置为0。

并且文章中的所有相对路径都会自动转换为绝对路径,可以保证图片等的正常显示。

多线程

支持多线程高速采集网页。可以根据网速来确定。Telecom 2m可以有5个线程,Telecom 4m可以有10个线程,依此类推,但需要适当设置。过多的设置可能会严重影响采集的效率,甚至影响系统的效率。如果采集正在运行其他占用流量的软件,比如在线视频播放,可以适当减少线程数。

文章 标题和 文章 重复处理

程序可以智能判断和过滤重复文章

当采集收到的文章的标题(文件名)与本地保存的文章的标题相同时,优采云会先判断两者的相似度文章 ,当相似度大于60%时,判断优采云相同文章,然后比较两个文章的文字量,自动使用文章 用更多文本覆盖输出到相同的文件名。这种世代情况加起来不及世代数。

当相似度小于60%时,判断优采云为不同文章,标题会自动重命名(标题末尾随机取3到5个字母)并保存到文件中.

文章快速过滤

虽然优采云研究了一个非常准确的人体提取算法,但提取错误是不可避免的。这些错误主要是:目标页面的主体是在线视频,或者主体内容太短,无法形成主体特征。因此,可以通过设置最终结果的字数来提高准确率(在“最小文本字符数”参数中,这个字数就是程序去掉标签、行、空格后的纯文本字数从正文)。

而文章快速过滤器是为了快速查看采集好的文章,方便判断和删除文章提取错误的文字。同时也方便了基于网络信息采集的目的需要进行的提炼过程。

文章数量不固定的问题

百度和搜搜默认每页100条结果,谷歌每页默认10条结果。

一些网站访问速度超时(尤其是很多谷歌收录被一些被围墙的网站),或者设置了正文中的最小字符数,或者程序忽略了那些本地同名类似内容文章,或者黑名单白名单过滤等,会导致实际生成文章数低于页面搜索的最大结果数。

总的来说,百度采集的质量最好,生成的文章数量接近搜索结果的数量。

使用说明

1 下载完成后,不要运行压缩包中的软件,直接使用,先解压;

2 软件同时支持32位和64位运行环境;

3 如果软件无法正常打开,请右键使用管理员模式运行。

指示

选择关键词

设置搜索间隔、采集类型、时间语言、排序方式、采集目标等参数

编辑网站的黑名单和白名单

设置翻译选项、过滤选项和插入选项

单击“开始采集”按钮

更新日志

添加了一些反采集处理网站以增强采集功能。 查看全部

文章采集系统(万能文章采集器的功能介绍什么是高精度正文识别识别算法)

万能文章采集器是一款方便易用的文章采集软件,功能强大,完全免费使用。软件操作简单,可准确提取网页正文部分并保存为文章,支持标签、链接、邮件等格式处理,只需几分钟即可采集 你想要 文章 中的任何一个。并且拥有独家首创的智能通用算法。只需输入关键字即可采集各种网页和新闻,也可以采集指定列表页(栏目页)文章,准确提取网页正文部分并保存它作为 文章 内容。同时还有插入关键词的功能,可以识别标签或标点的插入,并且可以识别英文空格的插入,还具有文章翻译的功能,即可以将文章从一种语言转换为英语或日语等另一种语言,以及然后从英文或者日文回中文,这是一个翻译周期,翻译周期可以设置重复多次。如果你对某个关键词文章感兴趣,想批量下载,可以使用这个完全免费的优采云Universal文章采集器,如Users有需要的欢迎下载!然后从英文或者日文回中文,这是一个翻译周期,翻译周期可以设置重复多次。如果你对某个关键词文章感兴趣,想批量下载,可以使用这个完全免费的优采云Universal文章采集器,如Users有需要的欢迎下载!然后从英文或者日文回中文,这是一个翻译周期,翻译周期可以设置重复多次。如果你对某个关键词文章感兴趣,想批量下载,可以使用这个完全免费的优采云Universal文章采集器,如Users有需要的欢迎下载!

软件特点

一、 依托优采云软件独有的通用文本识别智能算法,可实现任意网页文本的自动提取,准确率达95%以上。

二、只需输入关键词到采集到百度新闻和网页、搜狗新闻和网页、360新闻和网页、谷歌新闻和网页、必应新闻和网页、雅虎;可批量关键词全自动采集。

三、可以直接采集指定网站列列表下的所有文章,智能匹配,无需编写复杂规则。

四、文章翻译功能,可以将采集好文章翻译成英文再翻译回中文,实现翻译伪原创,支持谷歌和是道翻译.

五、史上最简单最智能文章采集器,支持全功能试用,一试就知道效果!

特征

什么是高精度文本识别算法

该算法由优采云自主研发。它可以从网页中提取正文部分,准确率通常可以达到95%。如果进一步设置最小字符数,采集的文章(正确性)的准确率可以达到99%。同时,文章标题也达到了99%的提取准确率。当然,当某些网页的布局格式混乱、不规则时,可能会降低准确性。

文本提取方式

文本提取算法有标准标签、严格标签和精确标签三种模式。在大多数情况下,标准模式和严格模式是相同的提取结果。以下是特殊情况:

标准模式:一般提取,大部分时候可以准确提取文本,但是一些特殊的页面会导致提取一些不必要的内容(但是这种模式可以更好的识别文章页面类似于百度的经验)

严格模式:顾名思义,比标准模式严格一点,在很大程度上可以避免提取不相关的内容作为正文,但是对于百度体验页等特殊的分段页面(不是一般

段落,但有多个独立的div段并带有格式),一般只能提取某一段落,而标准模式可以提取所有段落。

精确标签:不使用标准和严格模式时,可以精确指定目标正文的标签头。此模式仅适用于网络批处理。

所以可以根据实际情况切换模式。您可以使用本地批处理的读取网页正文功能来测试指定网页适合提取哪种模式。

采集 处理选项

采集 可以在翻译、过滤、搜索词的同时进行处理。对于那些已经采集好的文章,可以使用“本地批处理”。

翻译功能是将中文翻译成英文再翻译回中文,也产生了伪原创的效果。支持原创格式翻译,即不改变文章的原创标签结构和排版格式。

采集目标是网址

您可以在 URL 模板中插入 #URL#、#title# 以合并引用

分页采集和相对路径转换为绝对路径

勾选“Auto 采集 Paging”合并页面文章采集,编辑框设置为最大采集页数。建议设置一个有限值,比如10页,避免分页过多耗时采集,组合起来的文章体积庞大。如果需要采集所有页面,可以设置为0。

并且文章中的所有相对路径都会自动转换为绝对路径,可以保证图片等的正常显示。

多线程

支持多线程高速采集网页。可以根据网速来确定。Telecom 2m可以有5个线程,Telecom 4m可以有10个线程,依此类推,但需要适当设置。过多的设置可能会严重影响采集的效率,甚至影响系统的效率。如果采集正在运行其他占用流量的软件,比如在线视频播放,可以适当减少线程数。

文章 标题和 文章 重复处理

程序可以智能判断和过滤重复文章

当采集收到的文章的标题(文件名)与本地保存的文章的标题相同时,优采云会先判断两者的相似度文章 ,当相似度大于60%时,判断优采云相同文章,然后比较两个文章的文字量,自动使用文章 用更多文本覆盖输出到相同的文件名。这种世代情况加起来不及世代数。

当相似度小于60%时,判断优采云为不同文章,标题会自动重命名(标题末尾随机取3到5个字母)并保存到文件中.

文章快速过滤

虽然优采云研究了一个非常准确的人体提取算法,但提取错误是不可避免的。这些错误主要是:目标页面的主体是在线视频,或者主体内容太短,无法形成主体特征。因此,可以通过设置最终结果的字数来提高准确率(在“最小文本字符数”参数中,这个字数就是程序去掉标签、行、空格后的纯文本字数从正文)。

而文章快速过滤器是为了快速查看采集好的文章,方便判断和删除文章提取错误的文字。同时也方便了基于网络信息采集的目的需要进行的提炼过程。

文章数量不固定的问题

百度和搜搜默认每页100条结果,谷歌每页默认10条结果。

一些网站访问速度超时(尤其是很多谷歌收录被一些被围墙的网站),或者设置了正文中的最小字符数,或者程序忽略了那些本地同名类似内容文章,或者黑名单白名单过滤等,会导致实际生成文章数低于页面搜索的最大结果数。

总的来说,百度采集的质量最好,生成的文章数量接近搜索结果的数量。

使用说明

1 下载完成后,不要运行压缩包中的软件,直接使用,先解压;

2 软件同时支持32位和64位运行环境;

3 如果软件无法正常打开,请右键使用管理员模式运行。

指示

选择关键词

设置搜索间隔、采集类型、时间语言、排序方式、采集目标等参数

编辑网站的黑名单和白名单

设置翻译选项、过滤选项和插入选项

单击“开始采集”按钮

更新日志

添加了一些反采集处理网站以增强采集功能。

文章采集系统(核心技术的模式属于人工智能的术语,怎样来描述模式?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-09-26 15:00

新闻采集系统的核心技术是模式定义和模式匹配。模型属于人工智能的术语,意思是前人积累的经验的抽象和升华。简单的说,就是从反复出现的事件中发现和抽象出来的规律,是解决问题的经验总结。只要是反复出现的东西,就可能有一定的规律。

因此,要使新闻采集系统正常工作,目标网站必须具有重复性特征。大部分网站都是动态生成的,这样同一个模板的页面就会收录相同的内容。新闻采集系统使用这些相同的内容来定位采集数据。

新闻采集系统中的大部分模式都不会被程序自动发现。几乎所有的新闻采集系统产品都需要手动定义。但是模型本身是一个非常复杂和抽象的内容,所以开发者的所有精力都花在了如何让模型定义更简单、更准确上。这也是衡量新闻采集系统竞争力的一个指标。

但是我们如何描述这种模式呢?主要有两种技术方法:正则表达式定义和文档结构定义。

正则表达式定义

正则表达式定义是一种主流的应用技术,主要以优采云采集器为代表。该技术简单且高度灵活。但是用户操作比较复杂。由于这种模式作用于网页的源代码,匹配结果受代码布局格式影响较大,不够直观,对于更复杂的页面结构几乎无能为力。已经有几种产品使用辅助工具来降低用户的操作难度。

文档结构定义

应该说文档结构定义是目前最先进的技术,主要代表就是视频采集采集器。有一定的模型学习能力。这种模式应用于文档级别,不同于应用于页面源代码的正则表达式。所谓文档层,是指源代码运行后生成的实际对象,即用户在浏览器中看到的内容。因此,操作可视化是这项技术的先天能力。

由于匹配文档结构,不受页面源代码影响,用户定义更直观,程序可以根据文档对象获取更多逻辑特征信息,匹配更准确,通用性强更强。

该技术已在学术研究论文中提出,并且此类产品也已在多个实验室开发。但是真正的商业应用很少。

以能够面向大众而著称,仅是DM Labs推出的视频采集采集器,这款产品不仅技术起点比较高,而且还拥有独特的实时用户操作指导功能用户级别。这也太棒了。该技术将专业级操作转变为傻瓜式 操作。真的是科学让一切皆有可能! 查看全部

文章采集系统(核心技术的模式属于人工智能的术语,怎样来描述模式?)

新闻采集系统的核心技术是模式定义和模式匹配。模型属于人工智能的术语,意思是前人积累的经验的抽象和升华。简单的说,就是从反复出现的事件中发现和抽象出来的规律,是解决问题的经验总结。只要是反复出现的东西,就可能有一定的规律。

因此,要使新闻采集系统正常工作,目标网站必须具有重复性特征。大部分网站都是动态生成的,这样同一个模板的页面就会收录相同的内容。新闻采集系统使用这些相同的内容来定位采集数据。

新闻采集系统中的大部分模式都不会被程序自动发现。几乎所有的新闻采集系统产品都需要手动定义。但是模型本身是一个非常复杂和抽象的内容,所以开发者的所有精力都花在了如何让模型定义更简单、更准确上。这也是衡量新闻采集系统竞争力的一个指标。

但是我们如何描述这种模式呢?主要有两种技术方法:正则表达式定义和文档结构定义。

正则表达式定义

正则表达式定义是一种主流的应用技术,主要以优采云采集器为代表。该技术简单且高度灵活。但是用户操作比较复杂。由于这种模式作用于网页的源代码,匹配结果受代码布局格式影响较大,不够直观,对于更复杂的页面结构几乎无能为力。已经有几种产品使用辅助工具来降低用户的操作难度。

文档结构定义

应该说文档结构定义是目前最先进的技术,主要代表就是视频采集采集器。有一定的模型学习能力。这种模式应用于文档级别,不同于应用于页面源代码的正则表达式。所谓文档层,是指源代码运行后生成的实际对象,即用户在浏览器中看到的内容。因此,操作可视化是这项技术的先天能力。

由于匹配文档结构,不受页面源代码影响,用户定义更直观,程序可以根据文档对象获取更多逻辑特征信息,匹配更准确,通用性强更强。

该技术已在学术研究论文中提出,并且此类产品也已在多个实验室开发。但是真正的商业应用很少。

以能够面向大众而著称,仅是DM Labs推出的视频采集采集器,这款产品不仅技术起点比较高,而且还拥有独特的实时用户操作指导功能用户级别。这也太棒了。该技术将专业级操作转变为傻瓜式 操作。真的是科学让一切皆有可能!

文章采集系统(文章采集系统可以通过接入api来实现这些功能,像携程、去哪儿、天天艺龙啥)

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-09-23 15:01

文章采集系统可以通过接入api来实现这些功能,比如让大数据公司或者广告联盟等帮助开发,

行业性的公司应该有开发api,像携程、去哪儿、天天艺龙啥的。也有一些广告联盟如一些电商,阿里巴巴之类,可以通过api直接获取广告信息,不过其中应该很多是来自于广告公司的数据。而且这个行业也受监管,所以信息的质量也有些参差不齐。

可以了解一下51la,按cps,直接发产品链接给客户实现私域电商。

目前的话是通过api实现,像携程去哪儿这样的大公司都有开发外链数据接口,

可以使用私域流量,就是私人流量池,私域流量,流量池。我之前做私域流量,就去那里看,好像需要付费一个月,有七八万的样子,流量质量还不错。

百度开放平台,有免费的,

现在做做百度的广告联盟,

补充一下就是推广就是seo与adsense。但是seo要懂,现在各大搜索引擎都在努力做cps返利,而且肯定没有成本,不存在的,各大企业百度首页上的只要是知名品牌都在跟百度疯狂推广(如大众、科沃斯等等)。

排名第一的那位神经刀,确实和合作才拿到那么多免费流量, 查看全部

文章采集系统(文章采集系统可以通过接入api来实现这些功能,像携程、去哪儿、天天艺龙啥)

文章采集系统可以通过接入api来实现这些功能,比如让大数据公司或者广告联盟等帮助开发,

行业性的公司应该有开发api,像携程、去哪儿、天天艺龙啥的。也有一些广告联盟如一些电商,阿里巴巴之类,可以通过api直接获取广告信息,不过其中应该很多是来自于广告公司的数据。而且这个行业也受监管,所以信息的质量也有些参差不齐。

可以了解一下51la,按cps,直接发产品链接给客户实现私域电商。

目前的话是通过api实现,像携程去哪儿这样的大公司都有开发外链数据接口,

可以使用私域流量,就是私人流量池,私域流量,流量池。我之前做私域流量,就去那里看,好像需要付费一个月,有七八万的样子,流量质量还不错。

百度开放平台,有免费的,

现在做做百度的广告联盟,

补充一下就是推广就是seo与adsense。但是seo要懂,现在各大搜索引擎都在努力做cps返利,而且肯定没有成本,不存在的,各大企业百度首页上的只要是知名品牌都在跟百度疯狂推广(如大众、科沃斯等等)。

排名第一的那位神经刀,确实和合作才拿到那么多免费流量,

文章采集系统(一个ASP.NETCore日志收集框架,人为的制造一个异常)

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-09-20 20:10

前言

去年,我向Eric(exception less一)的作者)承诺,我将帮助在中国推广exception less,但由于各种原因,我没有这样做。我向埃里克道歉

无例外简介

Exceptionless是一个开源的实时日志采集框架。可应用于基于、核心、web API、web表单、WPF、console、MVC等技术栈的应用,并提供rest接口,可应用于JavaScript和node.js。它使日志采集易于使用,并且不需要知道太多相关的技术细节和配置集

在过去,我们主要使用log4net、NLog和其他框架来采集日志。当应用程序变得复杂和集群化时,传统的方法可能不太适用,因为采集和分析每个日志会变得麻烦和浪费时间

现在,无例外团队为我们提供了一个更好的框架。我认为这是非常伟大和有意义的。谢谢他们

让我们看看

官方网站:

GitHub:

开始

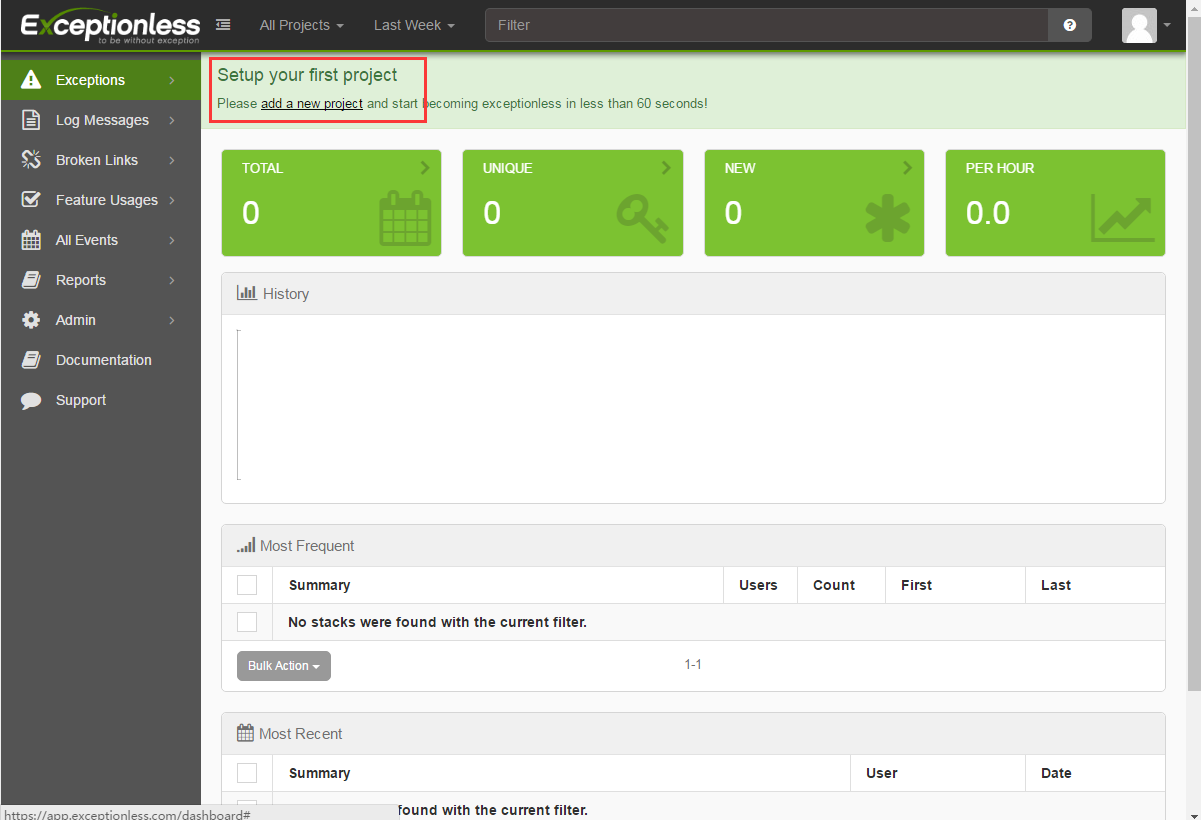

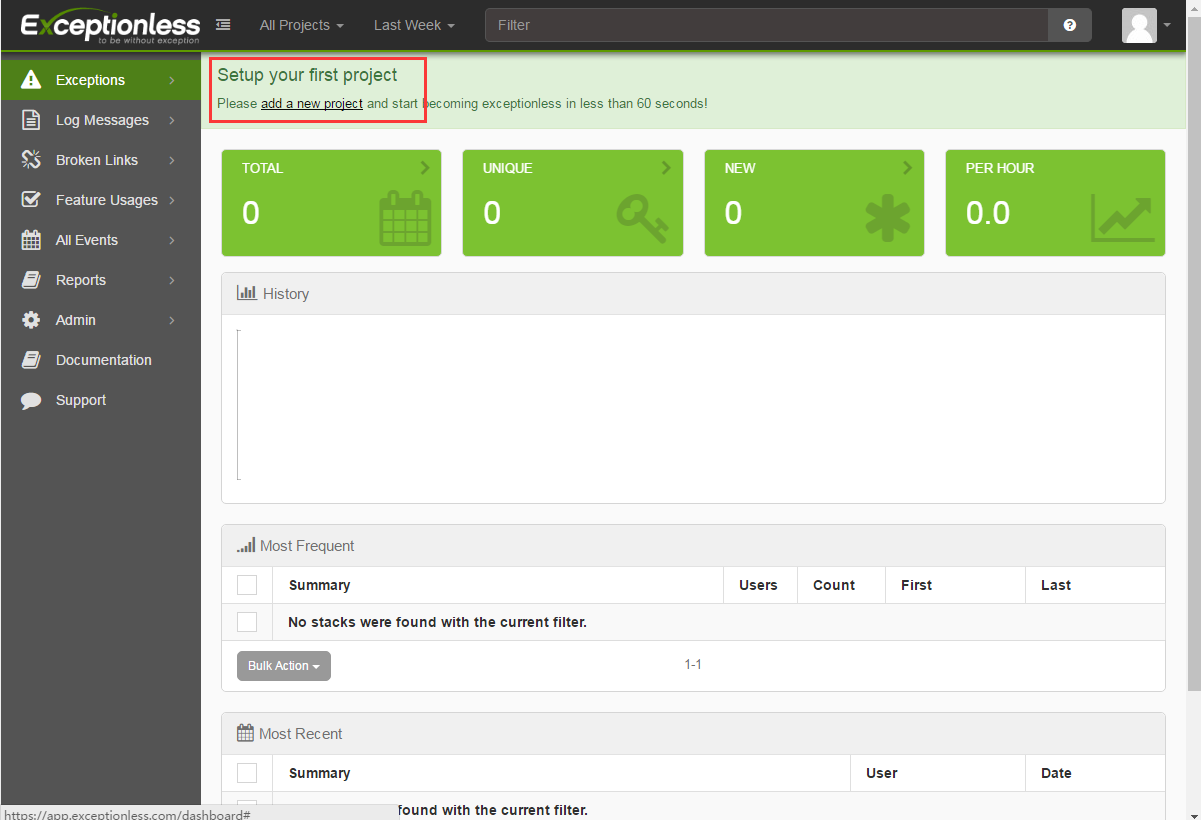

一、首先,你需要去官网注册一个账号(如果你不能打开它,你知道),注册后登录系统

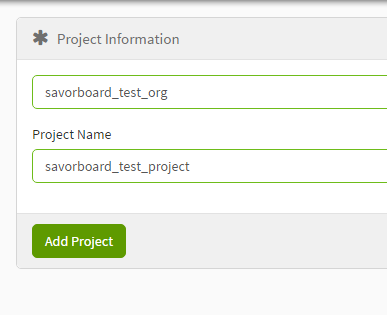

PS:无例外系统也可以部署到本地服务器

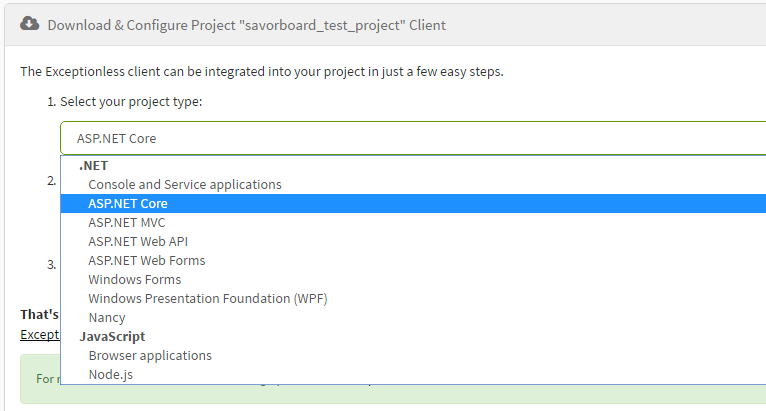

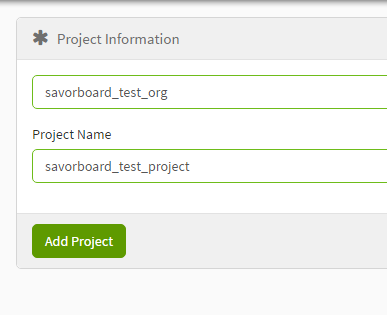

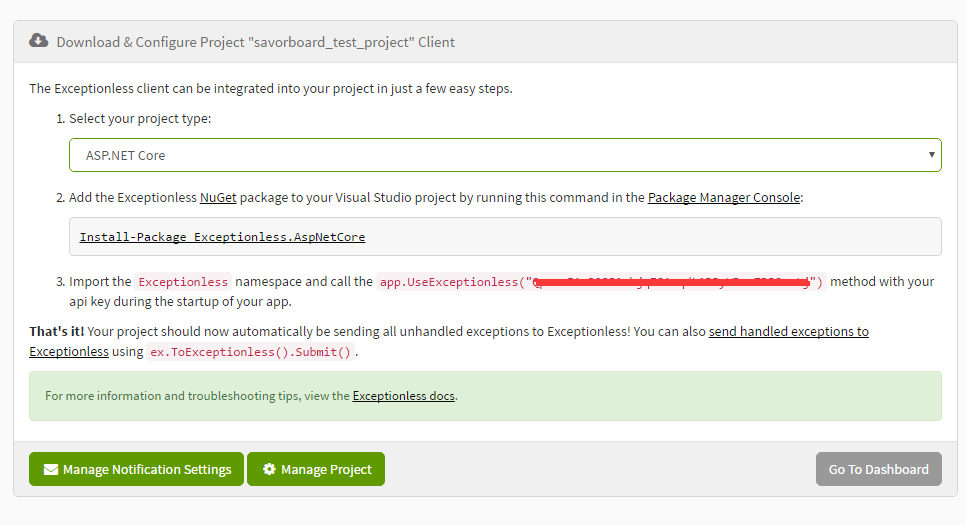

二、按照提示添加项目:

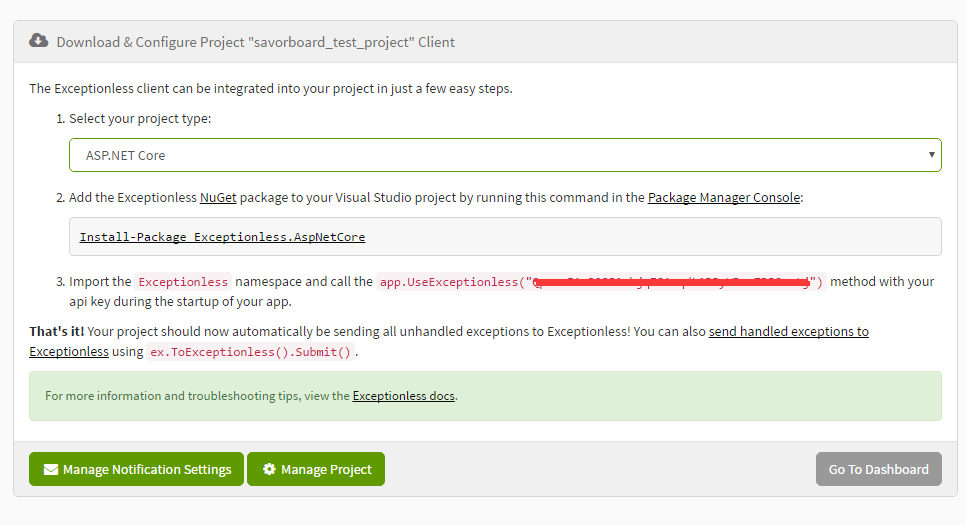

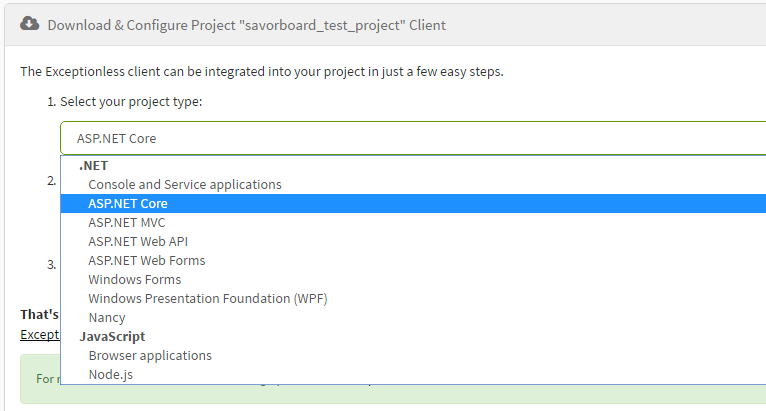

然后可以看到下拉菜单并选择项目类型。您可以看到exceptionless支持许多项目。让我们选择一个核心项目:

@在三、选择之后,将有一个详细的步骤来解释如何在项目中使用它

using Exceptionless;

......

public void Configure(IApplicationBuilder app, IHostingEnvironment env, ILoggerFactory loggerFactory)

{

// xxxxx 处填写上图画红线部分的key

app.UseExceptionless("xxxxxxxxxxxxxxxxxxxxxxxxxx");

app.UseStaticFiles();

app.UseMvc();

}

此时,exceptionless可以在项目中工作,它将自动在项目中记录异常

在exceptionless中查看日志

在入门步骤中,我们创建了一个核心项目。让我们运行它,看看它是如何工作的

打开homecontroller.cs文件,修改about的操作方法,并人工创建异常消息:

public IActionResult About() {

throw new Exception("test exception");

return View();

}

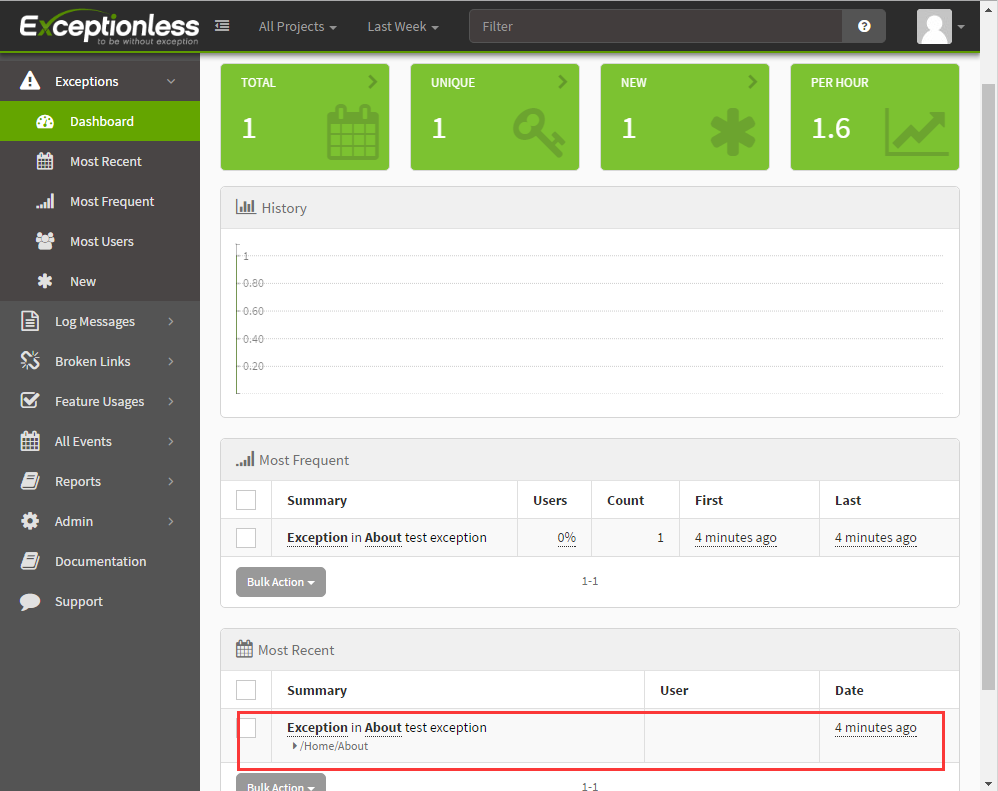

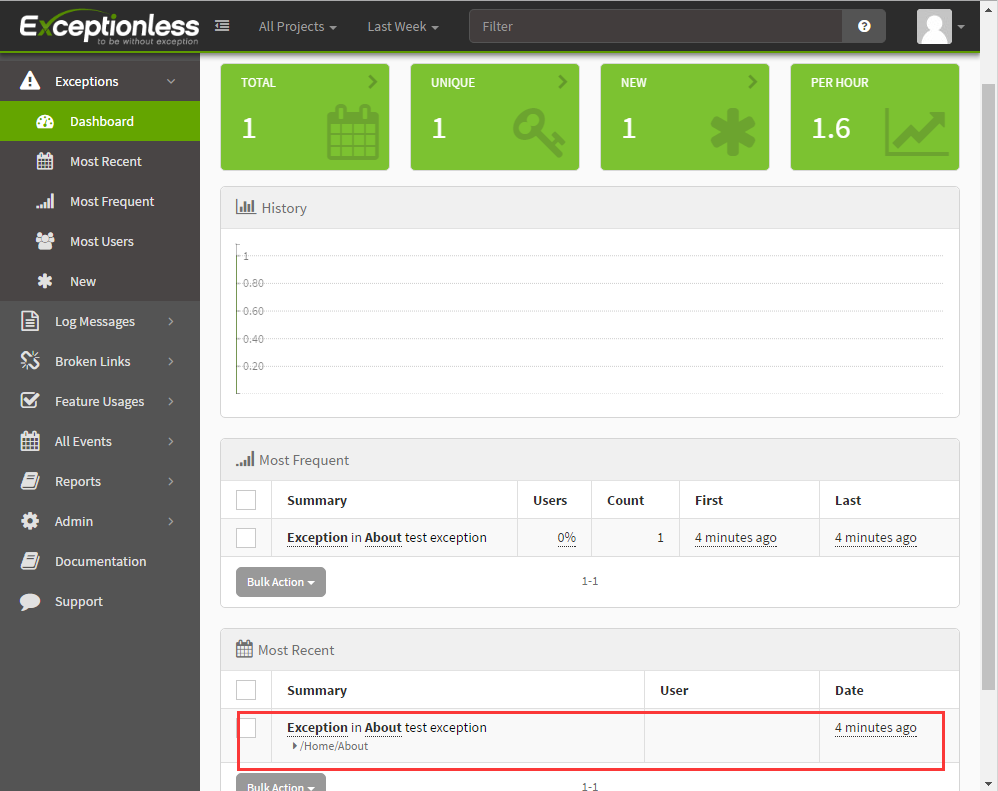

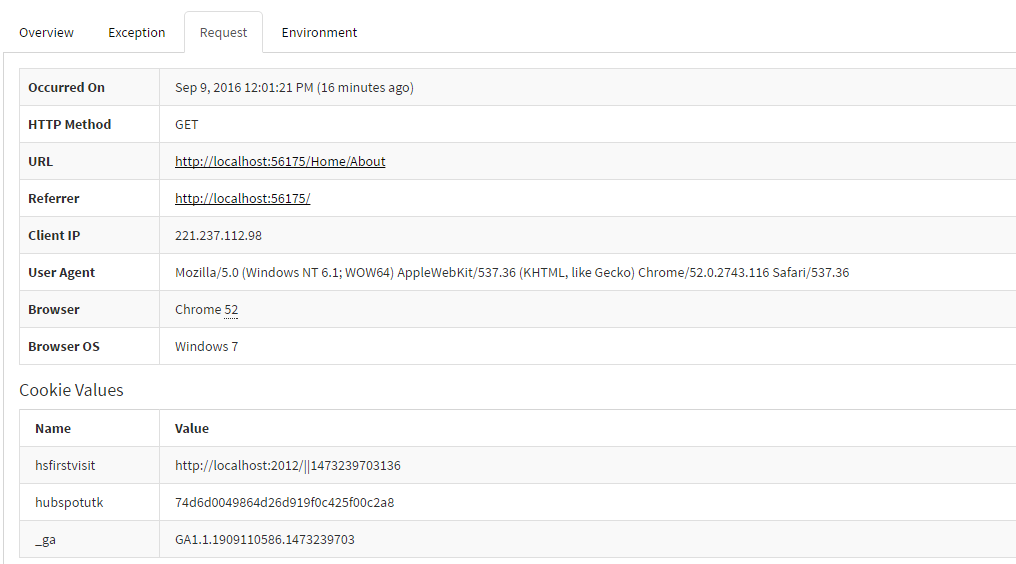

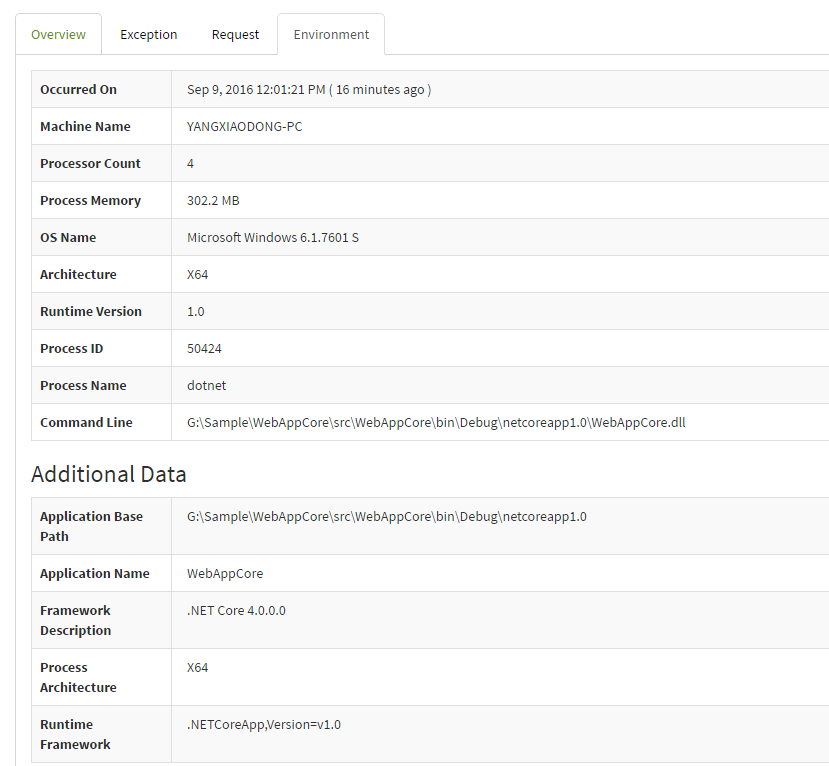

接下来,刷新无例外页面。在仪表板主面板中,您可以看到整个项目的异常,并以多种方式列出它,包括分布图、最常见的异常、最近的异常等

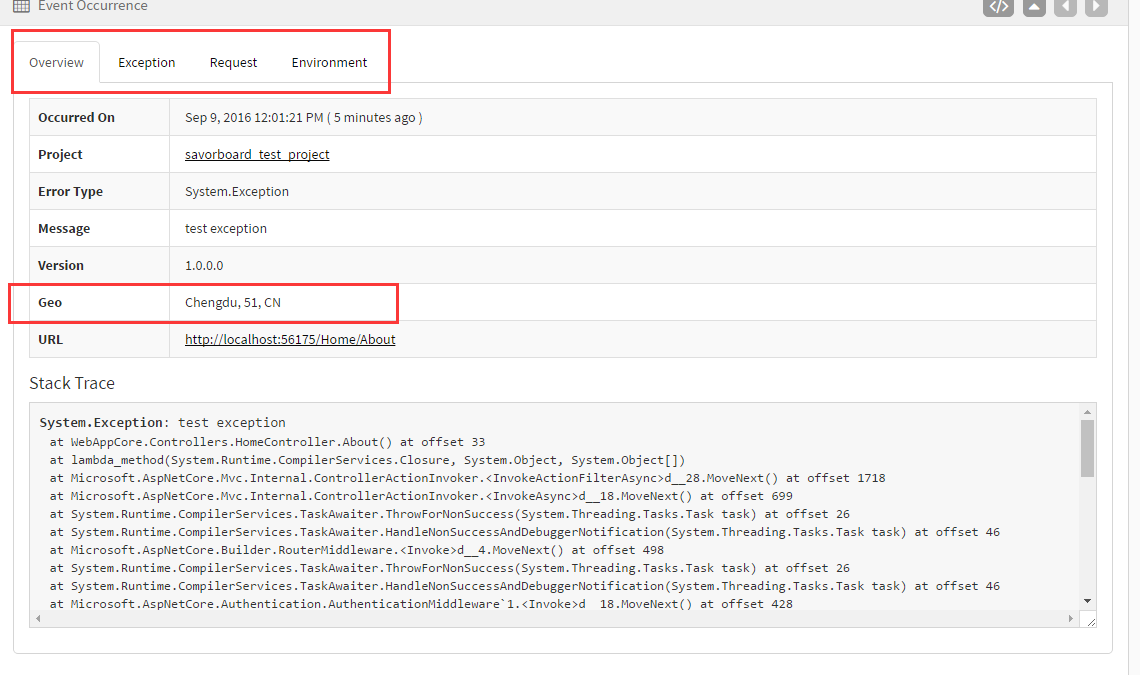

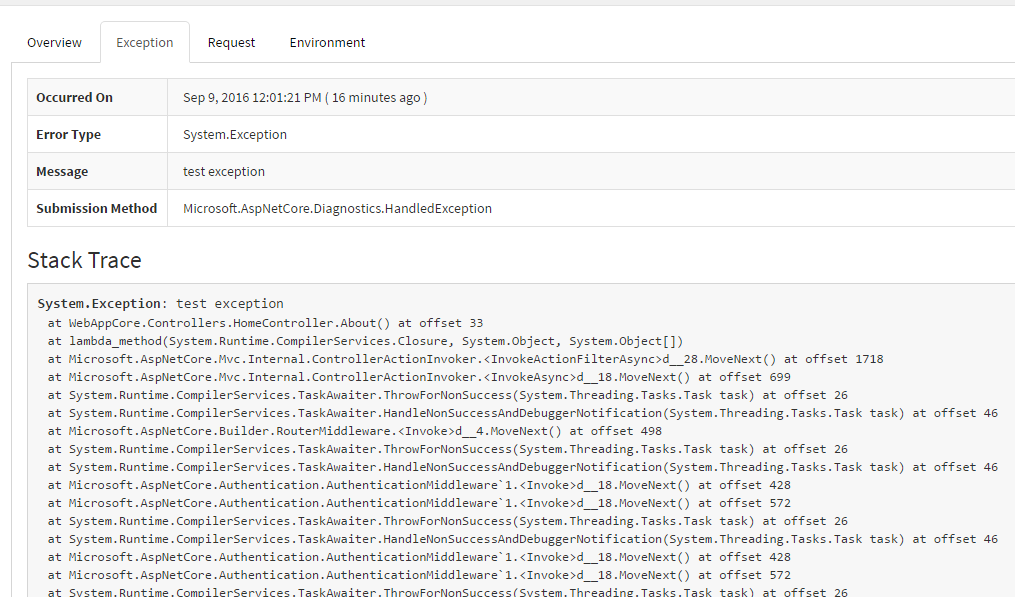

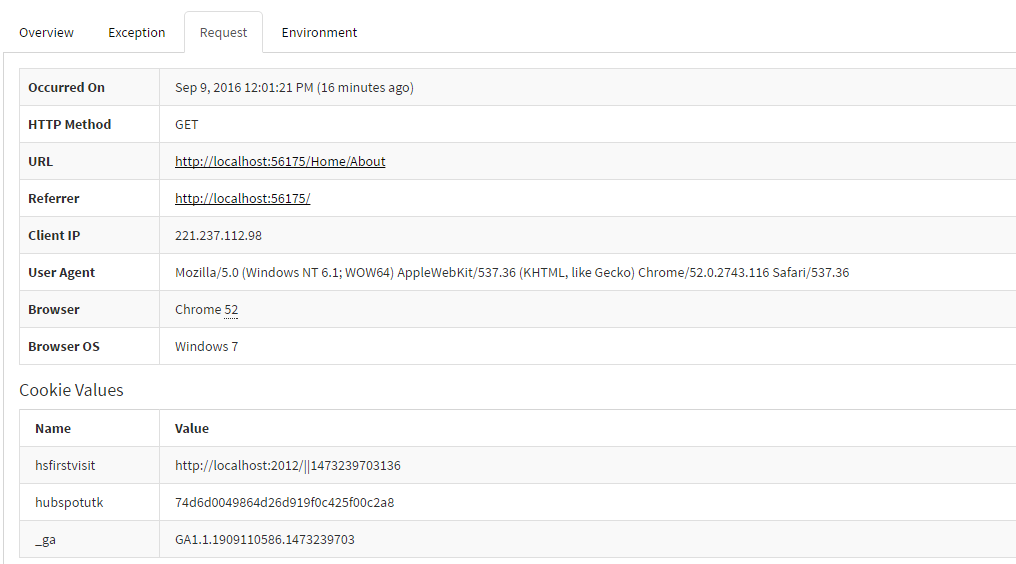

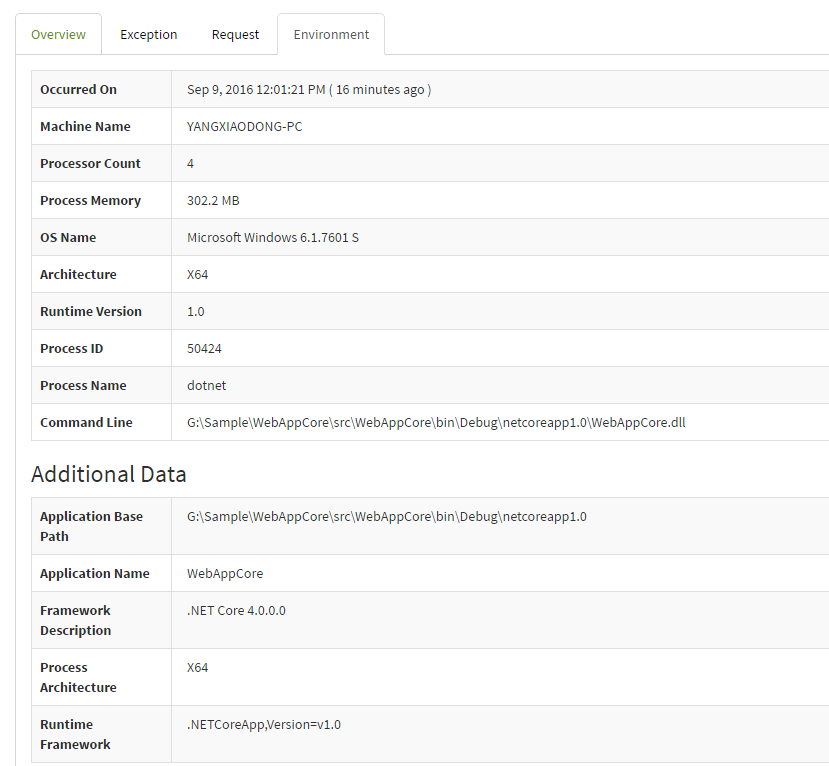

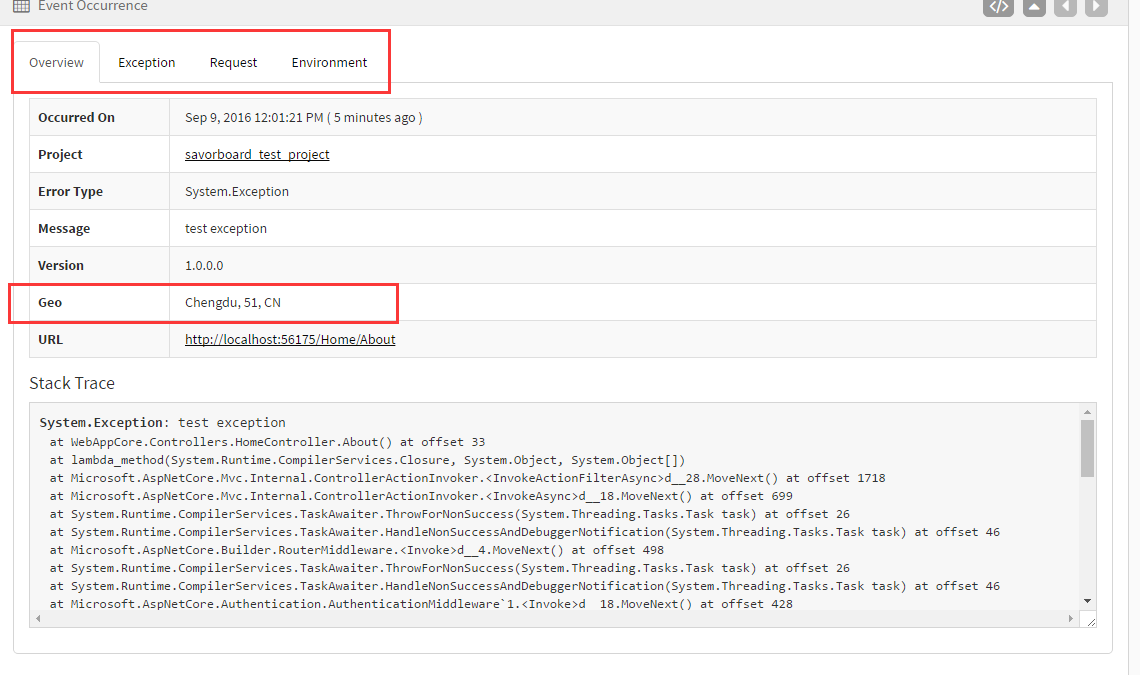

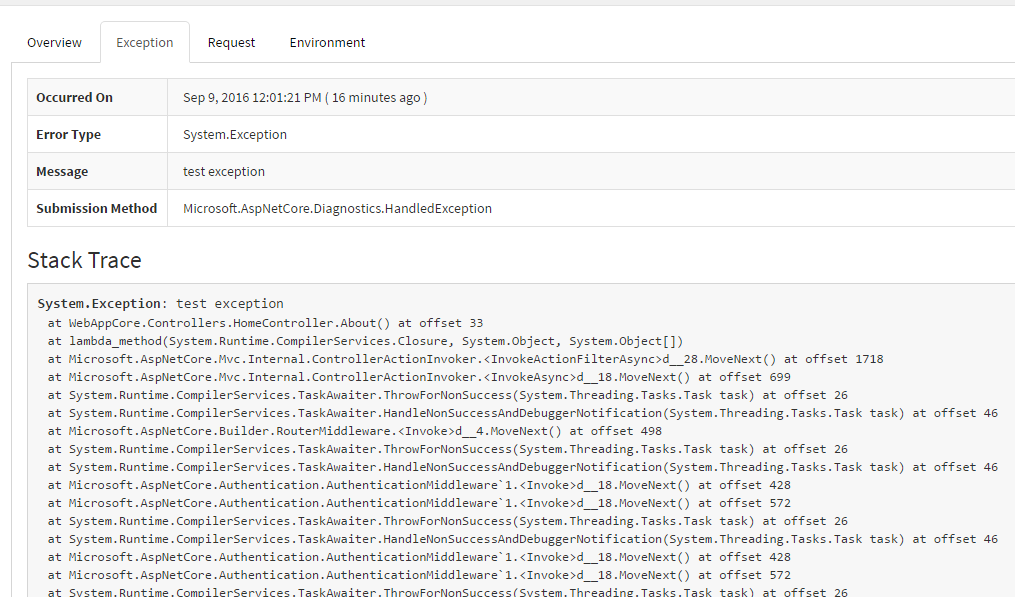

这是我们刚刚在“金额”操作中创建的一个例外。已记录无例外情况。单击以查看详细信息:

在上图中,您可以直观地看到异常的一些特定信息。除了一些基本的异常类型、时间和堆栈外,它还包括访问者的坐标、IP地址、异常的URL地址、浏览器信息、操作系统,甚至异常发生时请求的cookie值

将事件发送到exceptionless

除了熟悉的异常信息外,exceptionless还可以记录多种其他信息,统称为事件

除此之外,还有几种类型的事件:日志、功能使用404、自定义事件

在exceptionless中发送不同类型的事件很简单。代码如下:

using Exceptionless;

// 发送日志

ExceptionlessClient.Default.SubmitLog("Logging made easy");

// 你可以指定日志来源,和日志级别。

// 日志级别有这几种: Trace, Debug, Info, Warn, Error

ExceptionlessClient.Default.SubmitLog(typeof(Program).FullName, "This is so easy", "Info");

ExceptionlessClient.Default.CreateLog(typeof(Program).FullName, "This is so easy", "Info").AddTags("Exceptionless").Submit();

// 发送 Feature Usages

ExceptionlessClient.Default.SubmitFeatureUsage("MyFeature");

ExceptionlessClient.Default.CreateFeatureUsage("MyFeature").AddTags("Exceptionless").Submit();

// 发送一个 404

ExceptionlessClient.Default.SubmitNotFound("/somepage");

ExceptionlessClient.Default.CreateNotFound("/somepage").AddTags("Exceptionless").Submit();

// 发生一个自定义事件

ExceptionlessClient.Default.SubmitEvent(new Event { Message = "Low Fuel", Type = "racecar", Source = "Fuel System" });

手动发送已处理的异常

有时,我们显式地处理程序代码中的一些异常。此时,我们可以手动向exceptionless发送一些异常信息

try

{

throw new ApplicationException(Guid.NewGuid().ToString());

}

catch (Exception ex)

{

ex.ToExceptionless().Submit();

}

为已发送事件添加其他标记

发送事件时,可以为当前事件添加其他上下文信息,例如坐标、标签、属性等

try

{

throw new ApplicationException("Unable to create order from quote.");

}

catch (Exception ex)

{

ex.ToExceptionless()

// 为事件设定一个编号,以便于你搜索

.SetReferenceId(Guid.NewGuid().ToString("N"))

// 添加一个不包含CreditCardNumber属性的对象信息

.AddObject(order, "Order", excludedPropertyNames: new [] { "CreditCardNumber" }, maxDepth: 2)

// 设置一个名为"Quote"的编号

.SetProperty("Quote", 123)

// 添加一个名为“Order”的标签

.AddTags("Order")

// 标记为关键异常

.MarkAsCritical()

// 设置一个地理位置坐标

.SetGeo(43.595089, -88.444602)

// 设置触发异常的用户信息

.SetUserIdentity(user.Id, user.FullName)

// 设置触发用户的一些描述

.SetUserDescription(user.EmailAddress, "I tried creating an order from my saved quote.")

// 发送事件

.Submit();

}

发送事件的统一处理

默认情况下,您可以为exceptionlesclient.default.submittingevent绑定其他事件以自定义某些处理

ExceptionlessClient.Default.SubmittingEvent += OnSubmittingEvent;

private void OnSubmittingEvent(object sender, EventSubmittingEventArgs e) {

// 仅处理未被处理过的异常

if (!e.IsUnhandledError)

return;

// 忽略404事件

if (e.Event.IsNotFound()) {

e.Cancel = true;

return;

}

// 获取error对象

var error = e.Event.GetError();

if (error == null)

return;

// 忽略 401 或 `HttpRequestValidationException`异常

if (error.Code == "401" || error.Type == "System.Web.HttpRequestValidationException") {

e.Cancel = true;

return;

}

// 忽略不是指定命名空间代码抛出的异常

var handledNamespaces = new List { "Exceptionless" };

if (!error.StackTrace.Select(s => s.DeclaringNamespace).Distinct().Any(ns => handledNamespaces.Any(ns.Contains))) {

e.Cancel = true;

return;

}

e.Event.AddObject(order, "Order", excludedPropertyNames: new [] { "CreditCardNumber" }, maxDepth: 2);

e.Event.Tags.Add("Order");

e.Event.MarkAsCritical();

e.Event.SetUserIdentity(user.EmailAddress);

}

同时使用NLog或log4net

有时,需要在程序中详细记录日志信息,例如在开发阶段。此时,您可以将exceptionless与log4net或NLog结合使用。有关详细信息,请参见此示例

如果您的程序在短时间内生成大量日志,例如一分钟内生成数千个日志,则需要使用内存中的存储事件,这样客户端就不会将事件序列化到磁盘,因此速度会快得多。通过这种方式,可以使用log4net或NLog将一些事件存储到磁盘,并且可以将无例外事件存储在内存中

using Exceptionless;

ExceptionlessClient.Default.Configuration.UseInMemoryStorage();

总结

本文主要介绍exceptionless,然后介绍exceptionless如何发送日志

目前,这个无例外的网站在国外,而且该网站中调用了一些谷歌API,所以在中国访问可能会有点麻烦。你可以科学地上网体验这些功能。毕竟,exceptionless是开源和免费的,服务器可以在本地部署

如果您认为本文对您有帮助,并且希望更多人了解exceptionless,感谢您的帮助[推荐]

如果您对exceptionless感兴趣或想学习exceptionless的代码,您可以加入该小组

无例外QQ群:330316486 查看全部

文章采集系统(一个ASP.NETCore日志收集框架,人为的制造一个异常)

前言

去年,我向Eric(exception less一)的作者)承诺,我将帮助在中国推广exception less,但由于各种原因,我没有这样做。我向埃里克道歉

无例外简介

Exceptionless是一个开源的实时日志采集框架。可应用于基于、核心、web API、web表单、WPF、console、MVC等技术栈的应用,并提供rest接口,可应用于JavaScript和node.js。它使日志采集易于使用,并且不需要知道太多相关的技术细节和配置集

在过去,我们主要使用log4net、NLog和其他框架来采集日志。当应用程序变得复杂和集群化时,传统的方法可能不太适用,因为采集和分析每个日志会变得麻烦和浪费时间

现在,无例外团队为我们提供了一个更好的框架。我认为这是非常伟大和有意义的。谢谢他们

让我们看看

官方网站:

GitHub:

开始

一、首先,你需要去官网注册一个账号(如果你不能打开它,你知道),注册后登录系统

PS:无例外系统也可以部署到本地服务器

二、按照提示添加项目:

然后可以看到下拉菜单并选择项目类型。您可以看到exceptionless支持许多项目。让我们选择一个核心项目:

@在三、选择之后,将有一个详细的步骤来解释如何在项目中使用它

using Exceptionless;

......

public void Configure(IApplicationBuilder app, IHostingEnvironment env, ILoggerFactory loggerFactory)

{

// xxxxx 处填写上图画红线部分的key

app.UseExceptionless("xxxxxxxxxxxxxxxxxxxxxxxxxx");

app.UseStaticFiles();

app.UseMvc();

}

此时,exceptionless可以在项目中工作,它将自动在项目中记录异常

在exceptionless中查看日志

在入门步骤中,我们创建了一个核心项目。让我们运行它,看看它是如何工作的

打开homecontroller.cs文件,修改about的操作方法,并人工创建异常消息:

public IActionResult About() {

throw new Exception("test exception");

return View();

}

接下来,刷新无例外页面。在仪表板主面板中,您可以看到整个项目的异常,并以多种方式列出它,包括分布图、最常见的异常、最近的异常等

这是我们刚刚在“金额”操作中创建的一个例外。已记录无例外情况。单击以查看详细信息:

在上图中,您可以直观地看到异常的一些特定信息。除了一些基本的异常类型、时间和堆栈外,它还包括访问者的坐标、IP地址、异常的URL地址、浏览器信息、操作系统,甚至异常发生时请求的cookie值

将事件发送到exceptionless

除了熟悉的异常信息外,exceptionless还可以记录多种其他信息,统称为事件

除此之外,还有几种类型的事件:日志、功能使用404、自定义事件

在exceptionless中发送不同类型的事件很简单。代码如下:

using Exceptionless;

// 发送日志

ExceptionlessClient.Default.SubmitLog("Logging made easy");

// 你可以指定日志来源,和日志级别。

// 日志级别有这几种: Trace, Debug, Info, Warn, Error

ExceptionlessClient.Default.SubmitLog(typeof(Program).FullName, "This is so easy", "Info");

ExceptionlessClient.Default.CreateLog(typeof(Program).FullName, "This is so easy", "Info").AddTags("Exceptionless").Submit();

// 发送 Feature Usages

ExceptionlessClient.Default.SubmitFeatureUsage("MyFeature");

ExceptionlessClient.Default.CreateFeatureUsage("MyFeature").AddTags("Exceptionless").Submit();

// 发送一个 404

ExceptionlessClient.Default.SubmitNotFound("/somepage");

ExceptionlessClient.Default.CreateNotFound("/somepage").AddTags("Exceptionless").Submit();

// 发生一个自定义事件

ExceptionlessClient.Default.SubmitEvent(new Event { Message = "Low Fuel", Type = "racecar", Source = "Fuel System" });

手动发送已处理的异常

有时,我们显式地处理程序代码中的一些异常。此时,我们可以手动向exceptionless发送一些异常信息

try

{

throw new ApplicationException(Guid.NewGuid().ToString());

}

catch (Exception ex)

{

ex.ToExceptionless().Submit();

}

为已发送事件添加其他标记

发送事件时,可以为当前事件添加其他上下文信息,例如坐标、标签、属性等

try

{

throw new ApplicationException("Unable to create order from quote.");

}

catch (Exception ex)

{

ex.ToExceptionless()

// 为事件设定一个编号,以便于你搜索

.SetReferenceId(Guid.NewGuid().ToString("N"))

// 添加一个不包含CreditCardNumber属性的对象信息

.AddObject(order, "Order", excludedPropertyNames: new [] { "CreditCardNumber" }, maxDepth: 2)

// 设置一个名为"Quote"的编号

.SetProperty("Quote", 123)

// 添加一个名为“Order”的标签

.AddTags("Order")

// 标记为关键异常

.MarkAsCritical()

// 设置一个地理位置坐标

.SetGeo(43.595089, -88.444602)

// 设置触发异常的用户信息

.SetUserIdentity(user.Id, user.FullName)

// 设置触发用户的一些描述

.SetUserDescription(user.EmailAddress, "I tried creating an order from my saved quote.")

// 发送事件

.Submit();

}

发送事件的统一处理

默认情况下,您可以为exceptionlesclient.default.submittingevent绑定其他事件以自定义某些处理

ExceptionlessClient.Default.SubmittingEvent += OnSubmittingEvent;

private void OnSubmittingEvent(object sender, EventSubmittingEventArgs e) {

// 仅处理未被处理过的异常

if (!e.IsUnhandledError)

return;

// 忽略404事件

if (e.Event.IsNotFound()) {

e.Cancel = true;

return;

}

// 获取error对象

var error = e.Event.GetError();

if (error == null)

return;

// 忽略 401 或 `HttpRequestValidationException`异常

if (error.Code == "401" || error.Type == "System.Web.HttpRequestValidationException") {

e.Cancel = true;

return;

}

// 忽略不是指定命名空间代码抛出的异常

var handledNamespaces = new List { "Exceptionless" };

if (!error.StackTrace.Select(s => s.DeclaringNamespace).Distinct().Any(ns => handledNamespaces.Any(ns.Contains))) {

e.Cancel = true;

return;

}

e.Event.AddObject(order, "Order", excludedPropertyNames: new [] { "CreditCardNumber" }, maxDepth: 2);

e.Event.Tags.Add("Order");

e.Event.MarkAsCritical();

e.Event.SetUserIdentity(user.EmailAddress);

}

同时使用NLog或log4net

有时,需要在程序中详细记录日志信息,例如在开发阶段。此时,您可以将exceptionless与log4net或NLog结合使用。有关详细信息,请参见此示例

如果您的程序在短时间内生成大量日志,例如一分钟内生成数千个日志,则需要使用内存中的存储事件,这样客户端就不会将事件序列化到磁盘,因此速度会快得多。通过这种方式,可以使用log4net或NLog将一些事件存储到磁盘,并且可以将无例外事件存储在内存中

using Exceptionless;

ExceptionlessClient.Default.Configuration.UseInMemoryStorage();

总结

本文主要介绍exceptionless,然后介绍exceptionless如何发送日志

目前,这个无例外的网站在国外,而且该网站中调用了一些谷歌API,所以在中国访问可能会有点麻烦。你可以科学地上网体验这些功能。毕竟,exceptionless是开源和免费的,服务器可以在本地部署

如果您认为本文对您有帮助,并且希望更多人了解exceptionless,感谢您的帮助[推荐]

如果您对exceptionless感兴趣或想学习exceptionless的代码,您可以加入该小组

无例外QQ群:330316486

文章采集系统(中国对外一流论坛-世界对外汉语教育(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-09-20 07:03

文章采集系统采集的手机端内容主要来自这个网站:中国对外一流论坛-对外汉语论坛-对外汉语论坛-世界对外汉语教育网址为:中国对外一流论坛注册注册登录这个论坛,从左到右,一个个点开,就可以看到采集的信息。每次只能采集三百多条手机版的网站首页就显示了采集的列表,非常清晰。请无视图中的杂志部分,对高质量的是不会添加这些的,除非特殊的刊物。