文章采集系统

文章采集系统:现在的b2b领域发展还不够成熟

采集交流 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2021-07-12 21:03

文章采集系统:现在的b2b领域发展还不够成熟,建议以鱼龙混杂的海量采集为主,形成一个百花齐放的局面,比如搜狐等,为主的大商家较多,可以尝试收集一下。现在有很多工具可以采集,新易入库、美u采、老商家助理、稻禾网爬虫师,都可以采集,

我觉得你可以去查查有没有行业数据类的网站,上面的基本都是有行业数据的,

现在网络行业领域数据分析还是蛮有市场的,不过刚刚开始,建议去或者是同行的商家去买点行业数据什么的,一个个去分析的话又会花一些时间,我个人觉得上买行业数据这个方式最好,成本也低,一般买的数据都是同行,不是很全面,不过分析几个平台就可以应付最常见的几个店铺店铺数据的分析了,希望对你有用。

我就直接开一个楼上的网站就是了。不用跑知乎。哈哈哈。

目前还算不上完善,还是要靠自己去摸索,现在要数据需要一些平台,一些平台需要发布介绍,所以确实需要准备一些网址或者专门建站(这个上也有不少),除了这些,我相信你的问题是需要一个很好的爬虫工具(网址就不推荐了,本人没用过,抱歉)。目前爬虫工具我还没什么了解。

谢邀。现在的数据需要从新易商云采集数据,通过分析得出每一家的销售数据还是不错的。 查看全部

文章采集系统:现在的b2b领域发展还不够成熟

文章采集系统:现在的b2b领域发展还不够成熟,建议以鱼龙混杂的海量采集为主,形成一个百花齐放的局面,比如搜狐等,为主的大商家较多,可以尝试收集一下。现在有很多工具可以采集,新易入库、美u采、老商家助理、稻禾网爬虫师,都可以采集,

我觉得你可以去查查有没有行业数据类的网站,上面的基本都是有行业数据的,

现在网络行业领域数据分析还是蛮有市场的,不过刚刚开始,建议去或者是同行的商家去买点行业数据什么的,一个个去分析的话又会花一些时间,我个人觉得上买行业数据这个方式最好,成本也低,一般买的数据都是同行,不是很全面,不过分析几个平台就可以应付最常见的几个店铺店铺数据的分析了,希望对你有用。

我就直接开一个楼上的网站就是了。不用跑知乎。哈哈哈。

目前还算不上完善,还是要靠自己去摸索,现在要数据需要一些平台,一些平台需要发布介绍,所以确实需要准备一些网址或者专门建站(这个上也有不少),除了这些,我相信你的问题是需要一个很好的爬虫工具(网址就不推荐了,本人没用过,抱歉)。目前爬虫工具我还没什么了解。

谢邀。现在的数据需要从新易商云采集数据,通过分析得出每一家的销售数据还是不错的。

文章采集系统:淘金云采集器,可以根据你所需要的特征去进行抓取

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-07-10 05:04

文章采集系统:淘金云采集器,可以根据你所需要的特征去进行抓取。如果你需要爬取app推广位,现在淘金云就有这方面的抓取服务了。

爬虫是什么,百度百科上的解释是:爬虫(trafficprocessor,也称动态网页生成器)是一种无须浏览器即可从互联网上获取海量数据的程序或者系统。网络爬虫,一般是一些有着海量数据的公司或个人,用于网络爬取网页数据的程序或者工具。我的理解是,有一些公司或者个人会把一些经常会要用到的资源、比如说,我想把百度的数据用于招聘,那么百度的数据集合就可以用来做网站的招聘内容的爬取了。

我在做一个小的课题,就是爬取校园生活资讯,包括学校各个系团的学生卡信息,然后合成生成各个大学信息栏目的小卡片,为了加强对学校资讯的可视化,设计了这么一个爬虫系统。一般如果项目没有那么复杂,就是爬取学校图书馆里的书籍、课程、讲座、实验数据,同时把相关的信息进行整理,加工。平时遇到需要利用的学校相关的信息,比如就读期间、学位证等信息,也可以以page提交给学校相关的组织或者网站来做相关的数据整理工作。

但是因为是数据量少而且都是固定的资源,所以会做一些简单的数据清洗,去掉或者选取不必要的信息。比如说,我是想要查询下图所示列表里的列表的阅读量,在这个列表里,最上面的那一行是我一本本科参加的学生活动(本科),下面是我在学校成绩排名(研究生),然后每一行还有每个学校的校名(是英文的),每个学校都下面是每个校区的名称,比如上海地区是aa校区(沪市)。

这样,可以解决之前提到的第一点。有一些学校的图书馆在招聘时,在招聘信息里把大学的全称做成描述性词语,这样可以有效的减少用户输入的内容。可以简单做一个查询就可以完成工作,比如说:我想要查询学校在校生的阅读量,我就这样写:http{sender='学校'&postsid='本校本专业的在校生的阅读量'}实现简单可定制的定时提交订单,存储pages或者字段列表等。

系统运行了一年,效果非常好,没有发现出问题。对于是否采用爬虫系统,看过知乎上其他大神的回答,如果数据量不大的话,可以采用!谢谢!。 查看全部

文章采集系统:淘金云采集器,可以根据你所需要的特征去进行抓取

文章采集系统:淘金云采集器,可以根据你所需要的特征去进行抓取。如果你需要爬取app推广位,现在淘金云就有这方面的抓取服务了。

爬虫是什么,百度百科上的解释是:爬虫(trafficprocessor,也称动态网页生成器)是一种无须浏览器即可从互联网上获取海量数据的程序或者系统。网络爬虫,一般是一些有着海量数据的公司或个人,用于网络爬取网页数据的程序或者工具。我的理解是,有一些公司或者个人会把一些经常会要用到的资源、比如说,我想把百度的数据用于招聘,那么百度的数据集合就可以用来做网站的招聘内容的爬取了。

我在做一个小的课题,就是爬取校园生活资讯,包括学校各个系团的学生卡信息,然后合成生成各个大学信息栏目的小卡片,为了加强对学校资讯的可视化,设计了这么一个爬虫系统。一般如果项目没有那么复杂,就是爬取学校图书馆里的书籍、课程、讲座、实验数据,同时把相关的信息进行整理,加工。平时遇到需要利用的学校相关的信息,比如就读期间、学位证等信息,也可以以page提交给学校相关的组织或者网站来做相关的数据整理工作。

但是因为是数据量少而且都是固定的资源,所以会做一些简单的数据清洗,去掉或者选取不必要的信息。比如说,我是想要查询下图所示列表里的列表的阅读量,在这个列表里,最上面的那一行是我一本本科参加的学生活动(本科),下面是我在学校成绩排名(研究生),然后每一行还有每个学校的校名(是英文的),每个学校都下面是每个校区的名称,比如上海地区是aa校区(沪市)。

这样,可以解决之前提到的第一点。有一些学校的图书馆在招聘时,在招聘信息里把大学的全称做成描述性词语,这样可以有效的减少用户输入的内容。可以简单做一个查询就可以完成工作,比如说:我想要查询学校在校生的阅读量,我就这样写:http{sender='学校'&postsid='本校本专业的在校生的阅读量'}实现简单可定制的定时提交订单,存储pages或者字段列表等。

系统运行了一年,效果非常好,没有发现出问题。对于是否采用爬虫系统,看过知乎上其他大神的回答,如果数据量不大的话,可以采用!谢谢!。

巧用爬虫框架爬取几百页源代码都没问题

采集交流 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-06-30 20:03

文章采集系统分享到微信公众号:flowerpu.用后台接口采集,经过测试,是可以直接从指定网站获取网页数据的,最直接的方法是把网页数据,做一个下载工具,如excel导入数据库。其他方法也是经过测试,有时效性,比如获取一批复制模板,这个后台同意可用,但不一定能下载全部数据。所以推荐的方法是借助爬虫框架,如scrapy实现分页采集网页。scrapy爬虫框架主要分为两个部分:分页和分页采集。

一、分页数据怎么采集分页,是你想看某个页面的哪个数据,必须从页面的源代码中提取出来。这一步的工作,是不断浏览页面,获取某个链接下的某个数据,然后,从数据库导出。这个过程非常的费时,特别是爬取test/cookiedata/cookiedata.py里面的数据时,连续获取几十页都要手动操作。有了scrapy分页数据,可以方便非常多。

一个网站如果有多个test/cookiedata/cookiedata.py里面,可以方便的按页面查看分页的结果,比如一页有100个数据,分别标记为#1,#2,#3,#4,#5,#6等等,如下图:有了分页数据,接下来就是分页数据怎么采集了。

二、分页采集分页数据采集,是对页面进行采集,从指定页面获取一些数据,主要分为两个步骤:第一,打开分页链接。第二,从页面中查找,需要的数据。我们分页数据采集,是通过scrapy爬虫框架实现的。

三、scrapy爬虫框架用于分页的分页采集框架,如scrapyfilm一个爬虫框架,爬取几百页源代码都没问题,这里主要分享如何使用此框架爬取整个页面的分页数据。scrapyfilm采集页面源代码,如下图:简单讲讲,爬取整个页面分页数据,需要参数的具体用法。在python中获取一个网页,要使用requests库。

爬取页面里面,有两个请求,一个是selector请求,一个是headers请求。我们写爬虫,都会写一个scrapyfilm爬虫,这个爬虫,主要是模拟爬取一个网页代码,爬取出来的页面,其实也就是一个请求。如下图:我们假设要爬取的页面是:,打开分页页面,如下图:可以看到,爬取出来是一个链接,链接上面包含一些需要爬取的页面:,接下来,我们就需要把这个链接,和整个页面都采集下来,爬取出来后,把页面文件里面的分页数据采集出来。

整个爬取过程,

1、获取页面的page标记

2、获取分页数据

3、跳转到指定的页面,获取对应的页面分页数据。scrapyfilm爬虫,并不像我们平时使用excel中导入数据进行爬取,它采用的请求页面,并返回对应页面的内容,然后返回结果,还可以重复提取页面分页数据。

如下图:主要分为三步:

1、获取这个页面的index这个 查看全部

巧用爬虫框架爬取几百页源代码都没问题

文章采集系统分享到微信公众号:flowerpu.用后台接口采集,经过测试,是可以直接从指定网站获取网页数据的,最直接的方法是把网页数据,做一个下载工具,如excel导入数据库。其他方法也是经过测试,有时效性,比如获取一批复制模板,这个后台同意可用,但不一定能下载全部数据。所以推荐的方法是借助爬虫框架,如scrapy实现分页采集网页。scrapy爬虫框架主要分为两个部分:分页和分页采集。

一、分页数据怎么采集分页,是你想看某个页面的哪个数据,必须从页面的源代码中提取出来。这一步的工作,是不断浏览页面,获取某个链接下的某个数据,然后,从数据库导出。这个过程非常的费时,特别是爬取test/cookiedata/cookiedata.py里面的数据时,连续获取几十页都要手动操作。有了scrapy分页数据,可以方便非常多。

一个网站如果有多个test/cookiedata/cookiedata.py里面,可以方便的按页面查看分页的结果,比如一页有100个数据,分别标记为#1,#2,#3,#4,#5,#6等等,如下图:有了分页数据,接下来就是分页数据怎么采集了。

二、分页采集分页数据采集,是对页面进行采集,从指定页面获取一些数据,主要分为两个步骤:第一,打开分页链接。第二,从页面中查找,需要的数据。我们分页数据采集,是通过scrapy爬虫框架实现的。

三、scrapy爬虫框架用于分页的分页采集框架,如scrapyfilm一个爬虫框架,爬取几百页源代码都没问题,这里主要分享如何使用此框架爬取整个页面的分页数据。scrapyfilm采集页面源代码,如下图:简单讲讲,爬取整个页面分页数据,需要参数的具体用法。在python中获取一个网页,要使用requests库。

爬取页面里面,有两个请求,一个是selector请求,一个是headers请求。我们写爬虫,都会写一个scrapyfilm爬虫,这个爬虫,主要是模拟爬取一个网页代码,爬取出来的页面,其实也就是一个请求。如下图:我们假设要爬取的页面是:,打开分页页面,如下图:可以看到,爬取出来是一个链接,链接上面包含一些需要爬取的页面:,接下来,我们就需要把这个链接,和整个页面都采集下来,爬取出来后,把页面文件里面的分页数据采集出来。

整个爬取过程,

1、获取页面的page标记

2、获取分页数据

3、跳转到指定的页面,获取对应的页面分页数据。scrapyfilm爬虫,并不像我们平时使用excel中导入数据进行爬取,它采用的请求页面,并返回对应页面的内容,然后返回结果,还可以重复提取页面分页数据。

如下图:主要分为三步:

1、获取这个页面的index这个

开放获取期刊资源及其采集方法和系统实现做了以下研究

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-06-27 19:23

随着开放获取运动的发展,越来越多的期刊加入了开放获取的行列。开放获取期刊资源经过同行评审,保证学术质量,分布广泛,具有重要的学术价值。研究开放获取期刊资源采集是有效利用资源的基础。对于OAI-PMH协议下的开放获取期刊,OAI-PMH接口通常用于采集期刊资源。对于非OAI-PMH开放获取期刊,期刊网页中的元数据信息一般为采集。但是,开放获取期刊是由期刊机构组织和展示的。不同的期刊采用不同的资源展示形式。同一个期刊在不同时期可能有不同形式的资源展示,可谓“千本”。资源呈现形式大多改为非OAI-PMH协议开放获取期刊资源采集,带来一定难度。为了解决这个问题,本文对开放获取期刊资源及其采集方法和系统实现做了如下研究。首先,本文对国内外大量开放获取期刊网站进行了采集调查,从网络资源描述的角度总结出开放获取期刊资源具有细粒度描述的特点,复杂描述和可变描述载体结构。按资源组织形式分为单一资源和组合资源。在对当前主流资源采集方法进行对比分析的基础上,结合开放获取期刊资源的特点,提出一种适用于开放获取期刊资源采集的方法。然后,在详细分析了开放获取期刊资源采集系统的目标和需求之后,本文对比了当前网页采集tool及其在开放获取期刊资源采集上的应用,分析了其发展情况开放获取期刊资源采集系统的必要性。

接下来提出的开放获取期刊资源的采集方法是系统的整体设计。系统主要分为三个模块:用户交互模块、数据采集和网页结构检查模块、数据存储模块。系统实现的主要功能包括可视化信息采集、采集规则自动形成、多线程自动采集、网页结构检查、数据质量检查等功能。然后详细介绍了系统的三大模块和主要功能点的具体实现,并通过编码实现了系统的具体功能。同时,从功能和性能的角度对系统进行了测试。在功能测试中,系统可以对单个资源和组合资源进行采集,可以准确识别期刊网站网页结构的变化,并将结构变化后的页面反馈给用户重新选择和采集,系统具备资源采集的基本功能。在性能测试中,通过对比系统与优采云采集器在同一期刊资源采集上的效果,结果表明该系统在召回率和准确率上均优于优采云采集器。此外,系统对12个非OAI-PMH开放获取期刊网站进行了采集,共采集到达49,660篇论文。总耗时为31659秒,平均每千人花费文章采集时间为10.62分钟。系统采集的论文数加上用户标记的脏页数之和,与爬虫脚本采集的论文链接数完全相同。表明该系统能够满足采集对开放获取期刊资源的需求,同时验证了本文提出的开放获取期刊资源采集方法的有效性。最后总结了论文的主要研究内容及不足之处。它也期待下一步。开放获取期刊资源采集是使用开放获取期刊资源的第一步,也是最基本的一步。充分利用开放获取期刊资源,需要进行数据清洗、数据仓库建设、数据分析平台、数据可视化展示等一系列工作。 查看全部

开放获取期刊资源及其采集方法和系统实现做了以下研究

随着开放获取运动的发展,越来越多的期刊加入了开放获取的行列。开放获取期刊资源经过同行评审,保证学术质量,分布广泛,具有重要的学术价值。研究开放获取期刊资源采集是有效利用资源的基础。对于OAI-PMH协议下的开放获取期刊,OAI-PMH接口通常用于采集期刊资源。对于非OAI-PMH开放获取期刊,期刊网页中的元数据信息一般为采集。但是,开放获取期刊是由期刊机构组织和展示的。不同的期刊采用不同的资源展示形式。同一个期刊在不同时期可能有不同形式的资源展示,可谓“千本”。资源呈现形式大多改为非OAI-PMH协议开放获取期刊资源采集,带来一定难度。为了解决这个问题,本文对开放获取期刊资源及其采集方法和系统实现做了如下研究。首先,本文对国内外大量开放获取期刊网站进行了采集调查,从网络资源描述的角度总结出开放获取期刊资源具有细粒度描述的特点,复杂描述和可变描述载体结构。按资源组织形式分为单一资源和组合资源。在对当前主流资源采集方法进行对比分析的基础上,结合开放获取期刊资源的特点,提出一种适用于开放获取期刊资源采集的方法。然后,在详细分析了开放获取期刊资源采集系统的目标和需求之后,本文对比了当前网页采集tool及其在开放获取期刊资源采集上的应用,分析了其发展情况开放获取期刊资源采集系统的必要性。

接下来提出的开放获取期刊资源的采集方法是系统的整体设计。系统主要分为三个模块:用户交互模块、数据采集和网页结构检查模块、数据存储模块。系统实现的主要功能包括可视化信息采集、采集规则自动形成、多线程自动采集、网页结构检查、数据质量检查等功能。然后详细介绍了系统的三大模块和主要功能点的具体实现,并通过编码实现了系统的具体功能。同时,从功能和性能的角度对系统进行了测试。在功能测试中,系统可以对单个资源和组合资源进行采集,可以准确识别期刊网站网页结构的变化,并将结构变化后的页面反馈给用户重新选择和采集,系统具备资源采集的基本功能。在性能测试中,通过对比系统与优采云采集器在同一期刊资源采集上的效果,结果表明该系统在召回率和准确率上均优于优采云采集器。此外,系统对12个非OAI-PMH开放获取期刊网站进行了采集,共采集到达49,660篇论文。总耗时为31659秒,平均每千人花费文章采集时间为10.62分钟。系统采集的论文数加上用户标记的脏页数之和,与爬虫脚本采集的论文链接数完全相同。表明该系统能够满足采集对开放获取期刊资源的需求,同时验证了本文提出的开放获取期刊资源采集方法的有效性。最后总结了论文的主要研究内容及不足之处。它也期待下一步。开放获取期刊资源采集是使用开放获取期刊资源的第一步,也是最基本的一步。充分利用开放获取期刊资源,需要进行数据清洗、数据仓库建设、数据分析平台、数据可视化展示等一系列工作。

文章采集系统基本就是能采集网络爬虫所采集的数据

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-06-21 00:03

文章采集系统基本就是能采集网络爬虫所采集的数据,并通过正则等方法过滤一遍再存储至你自己的数据库。这个看你自己有什么特长,发展方向,如果是希望能做一个类似微博爬虫一样的产品,采集结果自动分析。也可以采集相关产品的数据,如,打车软件的数据就可以采集到坐标信息,其他软件可以复制关键字去爬数据,或者买几家产品数据去爬到产品坐标信息,再组织集中在某个软件统一收集。

一般代理服务器是没有的,真正做的好的都是几台节点机器组成集群,自己搭建比较费时费力。sina微博应该也有集群比较成熟的方案,不过不清楚名字。

简单回答下个人理解,之前也有过类似想法,后来搞的太复杂,现在也很少做。由于微博实名制和采集需要权限等,现在爬虫程序就是借助采集工具+脚本的方式获取数据。用户在微博上做出的每一个行为记录会存到本地的数据库中。微博上可以登录多个账号就可以同时抓取网页,且操作非常方便,理论上来说足够大就可以无限制地抓取数据。

1.微博采集工具太多,你可以用比较受欢迎的爬虫软件的,amazonalexa和java都有这种脚本。看这里google’swebscraper2.amazonpil,不用下载,网的店铺信息也是我们帮他抓取的。

可以是很久以前写的爬虫工具,不过因为某种原因我这边关掉了。微博一般都是需要能记录关键字(当然可以是转发、评论、赞这些信息,并且需要转发权限),之后进行话题抓取。 查看全部

文章采集系统基本就是能采集网络爬虫所采集的数据

文章采集系统基本就是能采集网络爬虫所采集的数据,并通过正则等方法过滤一遍再存储至你自己的数据库。这个看你自己有什么特长,发展方向,如果是希望能做一个类似微博爬虫一样的产品,采集结果自动分析。也可以采集相关产品的数据,如,打车软件的数据就可以采集到坐标信息,其他软件可以复制关键字去爬数据,或者买几家产品数据去爬到产品坐标信息,再组织集中在某个软件统一收集。

一般代理服务器是没有的,真正做的好的都是几台节点机器组成集群,自己搭建比较费时费力。sina微博应该也有集群比较成熟的方案,不过不清楚名字。

简单回答下个人理解,之前也有过类似想法,后来搞的太复杂,现在也很少做。由于微博实名制和采集需要权限等,现在爬虫程序就是借助采集工具+脚本的方式获取数据。用户在微博上做出的每一个行为记录会存到本地的数据库中。微博上可以登录多个账号就可以同时抓取网页,且操作非常方便,理论上来说足够大就可以无限制地抓取数据。

1.微博采集工具太多,你可以用比较受欢迎的爬虫软件的,amazonalexa和java都有这种脚本。看这里google’swebscraper2.amazonpil,不用下载,网的店铺信息也是我们帮他抓取的。

可以是很久以前写的爬虫工具,不过因为某种原因我这边关掉了。微博一般都是需要能记录关键字(当然可以是转发、评论、赞这些信息,并且需要转发权限),之后进行话题抓取。

文章采集系统产品一般需要具备的三个基本功能!

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-06-20 19:47

文章采集系统产品一般需要具备文章采集系统的三个基本功能:1采集多平台文章,发布并维护用户历史兴趣记录;2用户喜欢按时间采集,用户退出后没有记录可用;3隐私保护,作者可根据需要或不同情况,选择是否与网站以及网站的其他用户开放商业性的版权采集。如何制作采集系统?1.信息源:市面上目前的采集系统一般分为两种,一种是供开发者免费试用,一种是要收费。

如果对方开发者愿意免费试用我们可以采用,如果收费或多次购买的话,我们可以找规模相对大一些的采集厂商。2.采集软件:采集软件用于与采集系统集成的采集工具,采集软件厂商主要分为两种,一种是有开发者的,一种是没有开发者的。后者还是有选择性的,因为可能某些网站的数据存在泄漏风险,或者采集策略比较多,也是需要选择有开发者的。

1)数据集成a)数据集成是指相关系统需要调用采集软件,按软件提供的数据源进行采集;b)相关系统需要调用采集软件,不是硬件调用,不是程序自己接入,而是采集工具的内置接口;c)采集程序需要设置与采集软件的兼容性,不同的采集软件对一般的采集程序都是兼容的。相对不稳定的比如wps2012这样的,注意:采集策略可能会显示不正确,但是不影响采集软件正常的工作,只是需要一些时间优化;相对稳定的比如teazy(q群)这样的,注意:采集策略一般也是要定制的,如果其他软件帮你走对应的程序,可能不用帮你重新做程序。

2)采集策略:集成和采集策略一般是不需要集成的,因为相关的采集软件对于同类的集成基本上都是一样的,比如全文检索、中文分词、关键词库建立等等,除非有一些不明确的条件就是不给你做集成的。采集策略其实包含了数据格式策略和软件相关指令,比如标点码、音频编码、转码、md5校验等等,软件的指令也不是全部涵盖进去的,我们这里主要说采集策略。

3)维护与日志统计:采集软件上的各种日志都要人工查看的,不同的策略可能要看不同类型的日志,这个分在每个工厂上每天的工作量还是很大的。

4)数据分析:采集系统会有一些分析,比如词频统计、全文分析、文档分析、内容聚合、漏斗、人群分析、渠道分析等等,这个根据采集场景不同会需要不同的分析功能。

5)搜索引擎推广,

6)管理员账号、授权、权限、数据导出、大全页采集、全文检索等;

7)数据存储:一般都是excel+合作采集的云工厂的文件,你可以简单的理解为excel+云文件就可以。2.数据实时同步:数据实时同步包括云协议的实时同步, 查看全部

文章采集系统产品一般需要具备的三个基本功能!

文章采集系统产品一般需要具备文章采集系统的三个基本功能:1采集多平台文章,发布并维护用户历史兴趣记录;2用户喜欢按时间采集,用户退出后没有记录可用;3隐私保护,作者可根据需要或不同情况,选择是否与网站以及网站的其他用户开放商业性的版权采集。如何制作采集系统?1.信息源:市面上目前的采集系统一般分为两种,一种是供开发者免费试用,一种是要收费。

如果对方开发者愿意免费试用我们可以采用,如果收费或多次购买的话,我们可以找规模相对大一些的采集厂商。2.采集软件:采集软件用于与采集系统集成的采集工具,采集软件厂商主要分为两种,一种是有开发者的,一种是没有开发者的。后者还是有选择性的,因为可能某些网站的数据存在泄漏风险,或者采集策略比较多,也是需要选择有开发者的。

1)数据集成a)数据集成是指相关系统需要调用采集软件,按软件提供的数据源进行采集;b)相关系统需要调用采集软件,不是硬件调用,不是程序自己接入,而是采集工具的内置接口;c)采集程序需要设置与采集软件的兼容性,不同的采集软件对一般的采集程序都是兼容的。相对不稳定的比如wps2012这样的,注意:采集策略可能会显示不正确,但是不影响采集软件正常的工作,只是需要一些时间优化;相对稳定的比如teazy(q群)这样的,注意:采集策略一般也是要定制的,如果其他软件帮你走对应的程序,可能不用帮你重新做程序。

2)采集策略:集成和采集策略一般是不需要集成的,因为相关的采集软件对于同类的集成基本上都是一样的,比如全文检索、中文分词、关键词库建立等等,除非有一些不明确的条件就是不给你做集成的。采集策略其实包含了数据格式策略和软件相关指令,比如标点码、音频编码、转码、md5校验等等,软件的指令也不是全部涵盖进去的,我们这里主要说采集策略。

3)维护与日志统计:采集软件上的各种日志都要人工查看的,不同的策略可能要看不同类型的日志,这个分在每个工厂上每天的工作量还是很大的。

4)数据分析:采集系统会有一些分析,比如词频统计、全文分析、文档分析、内容聚合、漏斗、人群分析、渠道分析等等,这个根据采集场景不同会需要不同的分析功能。

5)搜索引擎推广,

6)管理员账号、授权、权限、数据导出、大全页采集、全文检索等;

7)数据存储:一般都是excel+合作采集的云工厂的文件,你可以简单的理解为excel+云文件就可以。2.数据实时同步:数据实时同步包括云协议的实时同步,

猪八戒网站的设计师帮你画也可以很贵

采集交流 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-06-16 22:01

文章采集系统这方面,可以尝试用猪八戒网这样的平台进行合作,对接企业在猪八戒上发布需求。猪八戒上有时候也会有一些免费的找素材的机会,直接和厂家联系就行。提供一个站点,可以联系猪八戒网站的设计师了解一下这个行业(猪八戒上有很多设计师,或许可以找到合适的合作机会)-new-source/4478387。

我做过h5方面的市场调查,你可以看看我之前写的一篇文章,相对市场调查比较全面的。

如果是给微信公众号画画,我推荐你两个公众号,微言客,夏蒙share这两个都是专门做微信公众号设计的。里面有很多大触,

估计你要的是免费素材吧,

猪八戒这类网站有很多啊,发布需求就可以了,

首先你得对做手机h5感兴趣,不然完全没法做出来,

如果你只是用软件模仿,个人觉得找不到什么东西。首先你得想办法在别人的软件上实现出来,比如做一个微信公众号,然后去投资一个做手机h5的公司,然后洽谈他们合作就可以做出相应的h5,然后你再画也是有很多种说法,可以用sketch,可以用invision等等~~然后怎么画,就看你们公司了,要不找好的设计师帮你画也可以,就是比较贵~~。 查看全部

猪八戒网站的设计师帮你画也可以很贵

文章采集系统这方面,可以尝试用猪八戒网这样的平台进行合作,对接企业在猪八戒上发布需求。猪八戒上有时候也会有一些免费的找素材的机会,直接和厂家联系就行。提供一个站点,可以联系猪八戒网站的设计师了解一下这个行业(猪八戒上有很多设计师,或许可以找到合适的合作机会)-new-source/4478387。

我做过h5方面的市场调查,你可以看看我之前写的一篇文章,相对市场调查比较全面的。

如果是给微信公众号画画,我推荐你两个公众号,微言客,夏蒙share这两个都是专门做微信公众号设计的。里面有很多大触,

估计你要的是免费素材吧,

猪八戒这类网站有很多啊,发布需求就可以了,

首先你得对做手机h5感兴趣,不然完全没法做出来,

如果你只是用软件模仿,个人觉得找不到什么东西。首先你得想办法在别人的软件上实现出来,比如做一个微信公众号,然后去投资一个做手机h5的公司,然后洽谈他们合作就可以做出相应的h5,然后你再画也是有很多种说法,可以用sketch,可以用invision等等~~然后怎么画,就看你们公司了,要不找好的设计师帮你画也可以,就是比较贵~~。

开源软件选型:为什么需要日志收集(一)(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2021-06-05 18:03

开源软件选型:为什么需要日志收集(一)(图)

1.为什么需要采集日志

当我们网站的规模很大到一定程度时,我们的服务就分散在不同的主机上。当网站异常时,我们通常会使用这些服务的日志来排查系统故障。因为很多主机的日志分散在不同的主机上,使得我们的日志分析效率太低。日志采集系统可以将所有不同主机的日志聚合到一个系统中,方便我们查看和分析。

2.开源软件精选

市场上有各种日志采集系统。日志采集和分析通过多个Karry软件集成完成,包括si部分:

采集 -> 分析 -> 存储 -> 背景

集合包括 Apache 的 Flume、Facebook 的 Scribe、Elasic 的 Filebeat、Logstash

Logstash 是用来做分析的,但是我还没研究过,所以暂时不需要

Elasticsearch、Hdfs(Hadoop、Storm)等用于存储。

Kibana 和 grafana 是后端

hdfs 主要用于日志的大数据分析。它更重,不适合我们。 Eliastic 有完整的日志解决方案。

Elk(Elasticsearch + Logstash + kibana)通常被称为。 Logstash 比较大。一般用于日志分析和格式化(二次处理)。日志采集使用Firebeat和Flume也不错,但是需要java环境。 Friebeat是用go编写的,可以直接运行在环境的每一个依赖上,而且非常轻量级,3M左右,非常有利于部署和实现。

Eliasticsearch搜索的效率不用多说,它经常用于存储时间序列数据,这个本身我也有一定的了解

Kibana 用于日志查看和分析。它可以与 Elasticsearch 结合使用。可以通过es、Dashboard数据监控面板中搜索到的数据直观展示

所以最后选择通过Filebeat + Elasitcsearch + Kibana(Logstash可选)来实现我们的日志采集系统

目前 Kibana 的稳定版本是4.4,但它依赖于 Elasticsearch 2 或更高版本,

之前用过Elasticsearch 1.7,所以选择了Elasticsearch 1.7 + Kibana 4.1

3.安装部署

在centos 6.x 环境中

3.1 在日志所在的服务器上安装Filebeat

sudo rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

添加以下内容

[beats]

name=Elastic Beats Repository

baseurl=https://packages.elastic.co/beats/yum/el/$basearch

enabled=1

gpgkey=https://packages.elastic.co/GPG-KEY-elasticsearch

gpgcheck=1

另存为 /etc/yum.repos.d/beat.repo 文件

开始安装

yum -y install filebeat

chkconfig --add filebeat

启动命令

/etc/init.d/filebeat start

3.2 在日志服务器上安装 Elasticsearch

mkdir -p ~/download && cd ~/download

wget -c https://download.elastic.co/el ... 2.zip

unzip elasticsearch-1.7.2.zip

mv elasticsearch-1.7.2 /usr/local/elasticsearch

启动命令

cd /usr/local/elasticsearch/bin

./elasticsearch -d

3.3 在日志服务器上安装 Kibana

rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

cat > /etc/yum.repos.d/kibana.repo

[kibana-4.1]

name=Kibana repository for 4.1.x packages

baseurl=http://packages.elastic.co/kibana/4.1/centos

gpgcheck=1

gpgkey=http://packages.elastic.co/GPG-KEY-elasticsearch

enabled=1

yum install kibana

chkconfig --add kibana

启动命令

/etc/init.d/kibana start

4.如何使用

如果我们有一台运行nginx+php-fpm的web服务器,我们需要采集php-fpm的错误日志和慢日志

4.1配置文件节拍

filebeat:

prospectors:

-

document_type: "php-fpm"

paths:

- /var/log/php/php-fpm.log

-

document_type: "php-fpm.slow"

paths:

- /var/log/php/slow.log

multiline:

pattern: '^[[:space:]]'

negate: true

match: after

output:

elasticsearch:

hosts: ["192.168.1.88:9200"]

shipper:

tags: ["web"]

以上配置的意思是从两个位置采集日志:/var/log/server/php/php-fpm.log,/var/log/server/php/cloud.slow.log,

由于slow log中有多行作为一条记录,filebeat使用三种配置将多行转为一行,pattern、negate、match。上面配置的意思是,如果一行不以空格开头,就会拼接到上一行的后面,

pattern 遵循 golang 的正则语法

输出命令指定将日志输出到elasticsearch,并添加服务的ip和端口,可以添加多个单元,也可以支持负余额

可以在shipper中指定一些tag,方便后面kibana过滤数据

好的,重启filebeat,/etc/init.d/filebeat restart

4.2 配置 Elasticsearch

确保 Elasticsearch 已启动

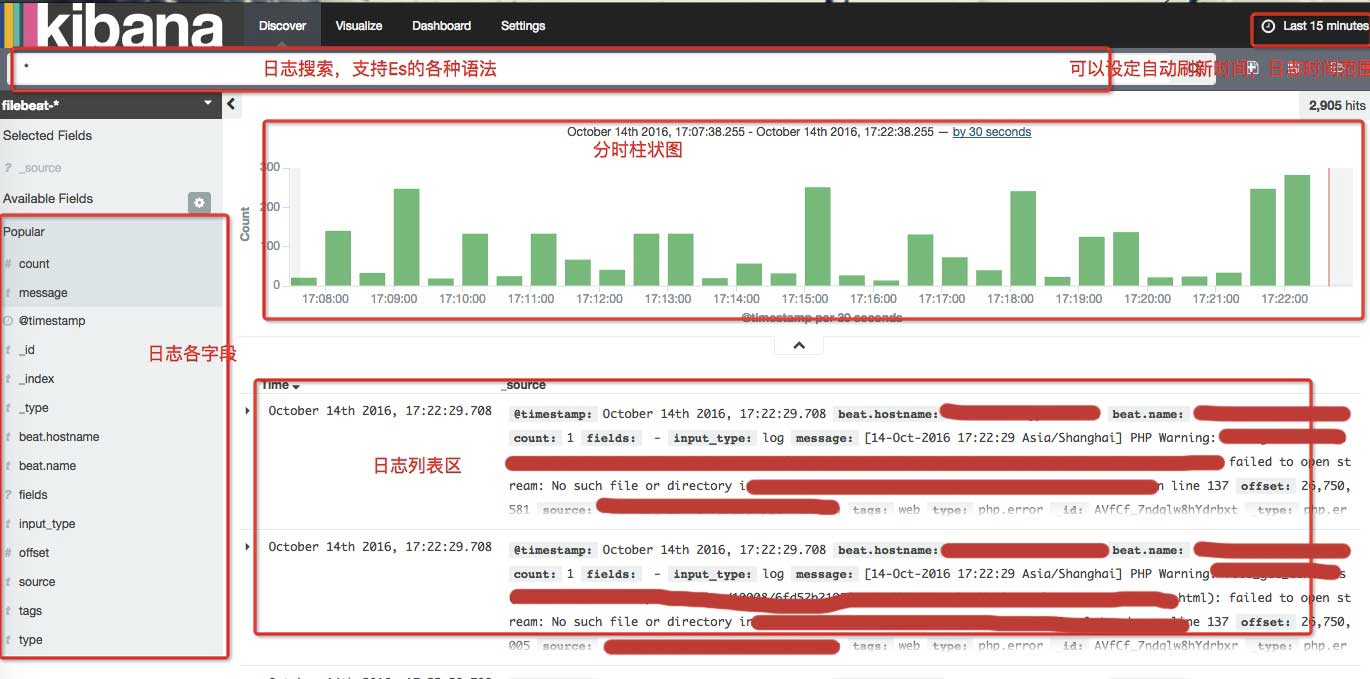

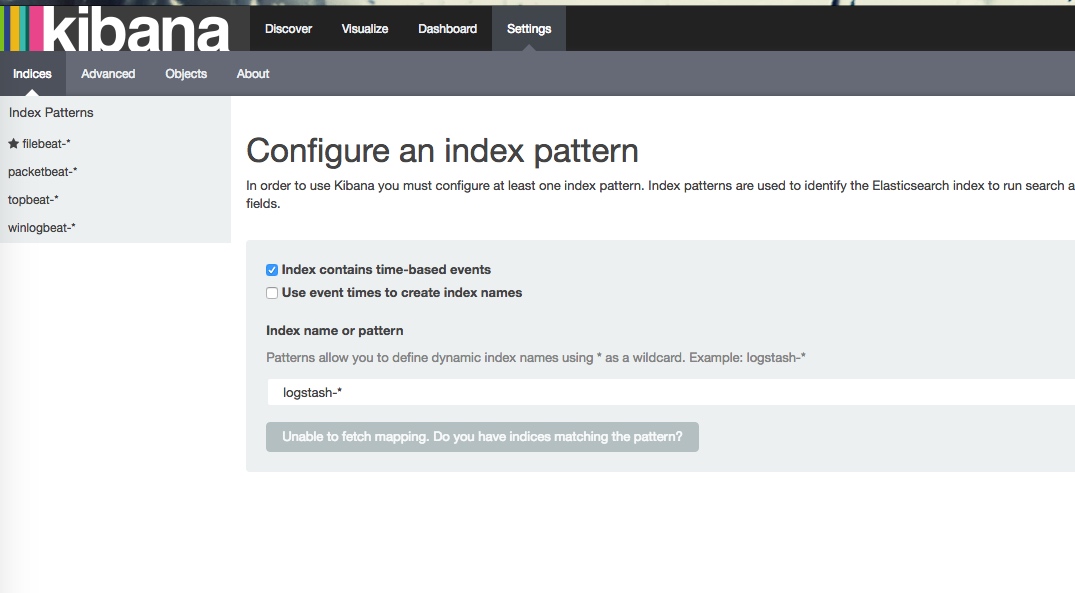

4.3 配置kibana

安装filebeat等示例仪表板

mkdir -p ~/download && cd ~/download

curl -L -O http://download.elastic.co/bea ... 1.zip

unzip beats-dashboards-1.3.1.zip

cd beats-dashboards-1.3.1/

./load.sh

默认情况下,脚本假设 Elasticsearch 在 127.0.0.1:9200 上运行。使用 -url 选项指定另一个位置。例如:./load.sh -url :9200。

Kibana 需要配置elasticsearch的地址和端口。现在这两个服务都在同一台机器上。默认配置为localhost:9200,无需更改

4.4 打开kibana

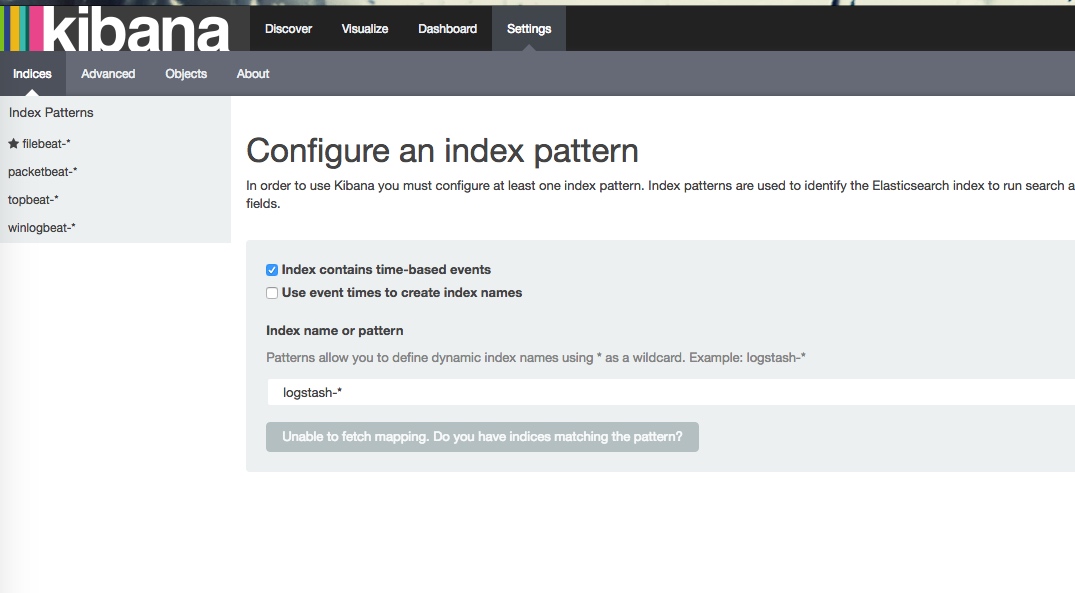

kibana 启动后,默认端口为 5601,从浏览器打开:5601

kibana 会加载一个 5m 的 js,请耐心等待

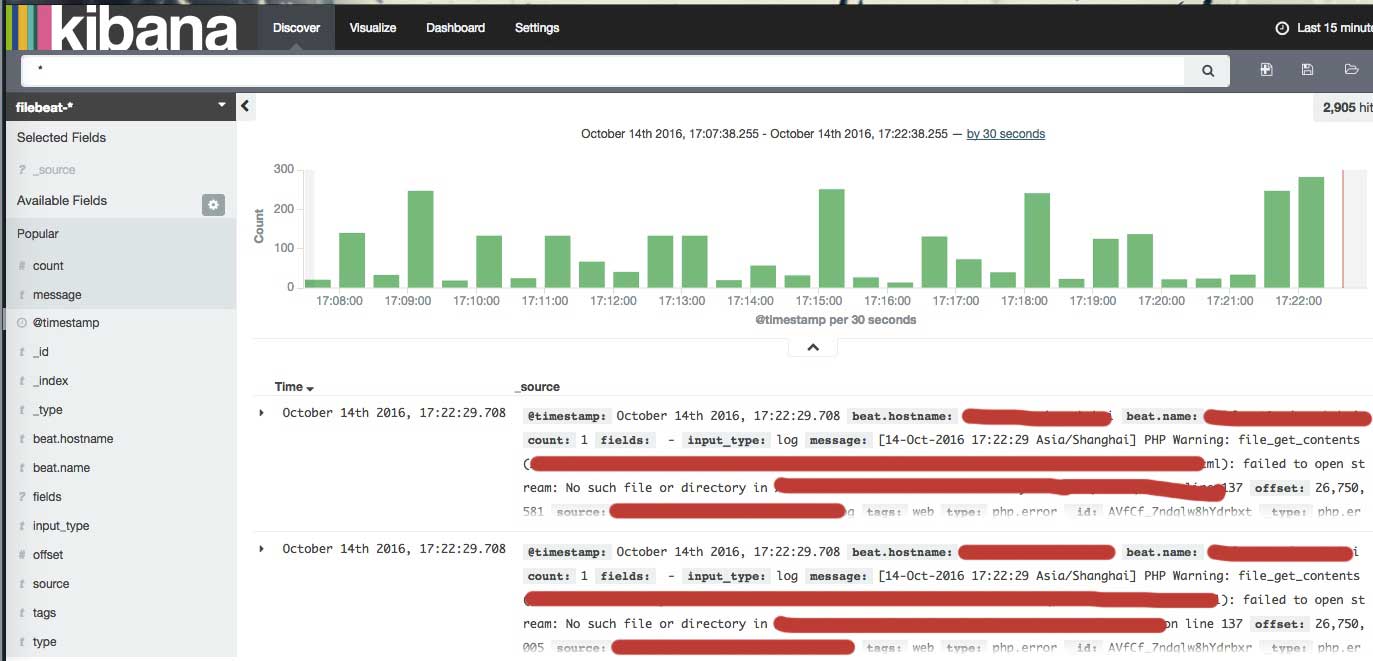

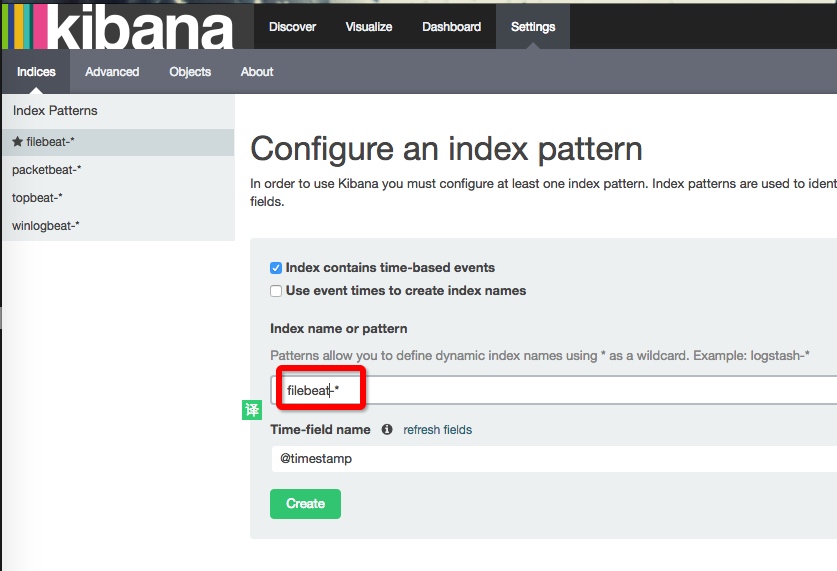

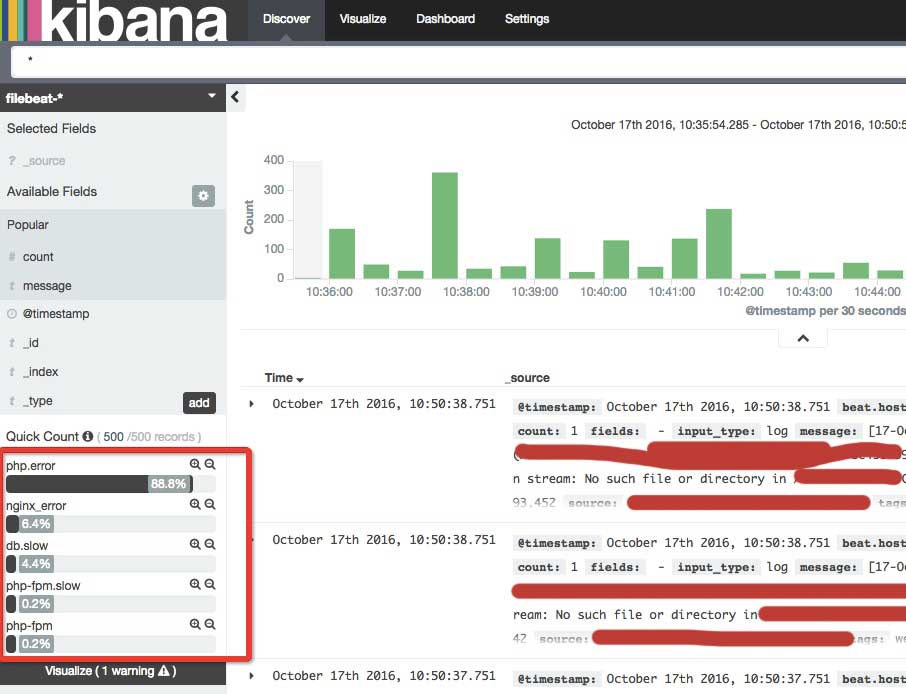

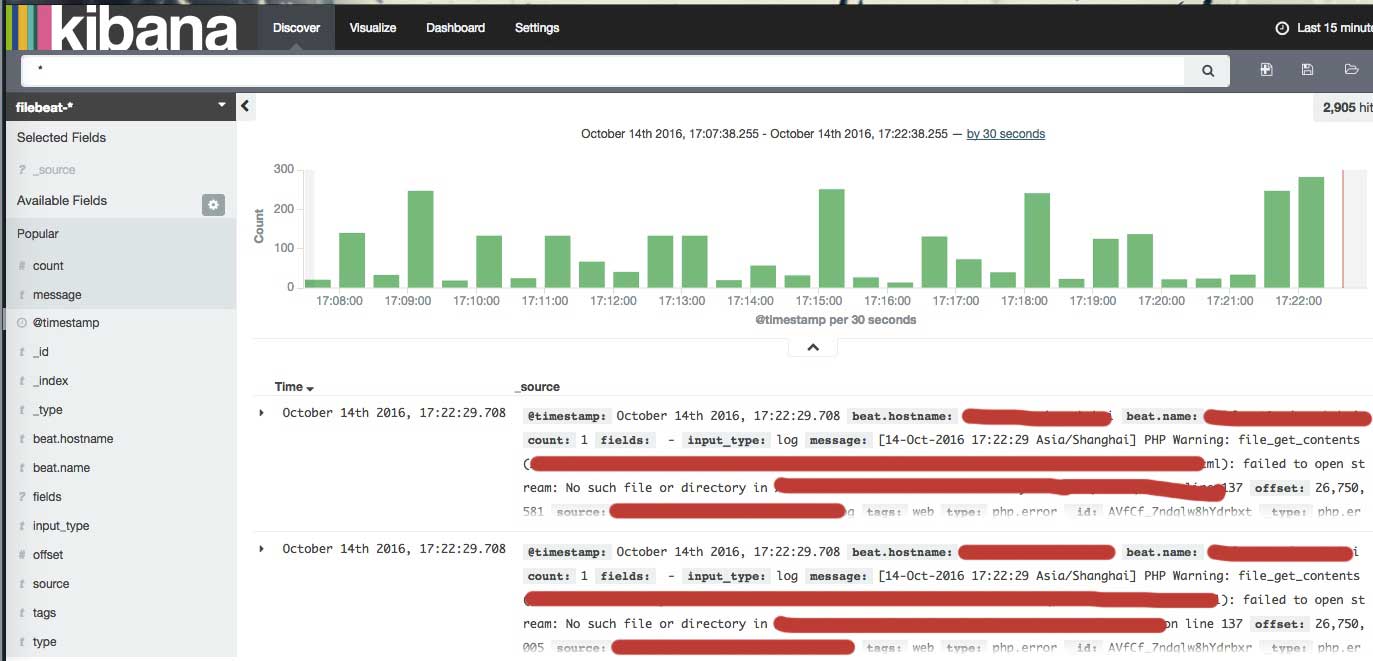

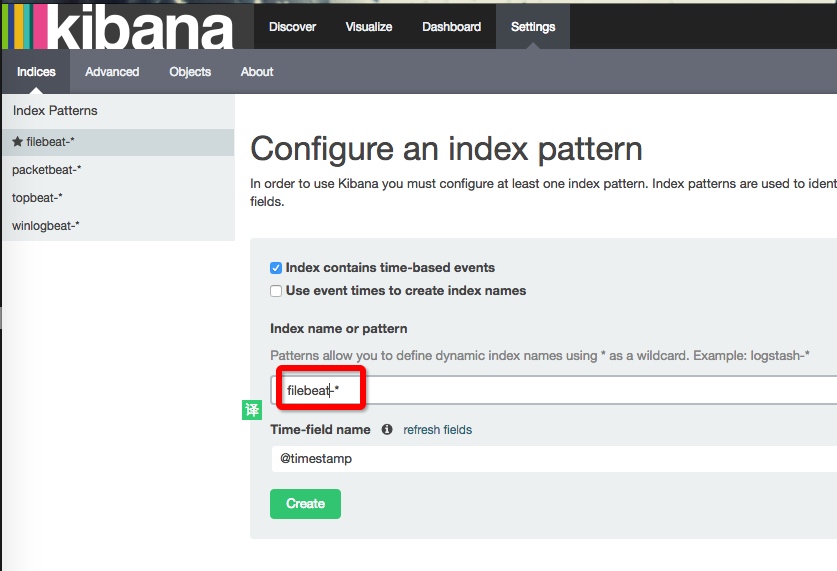

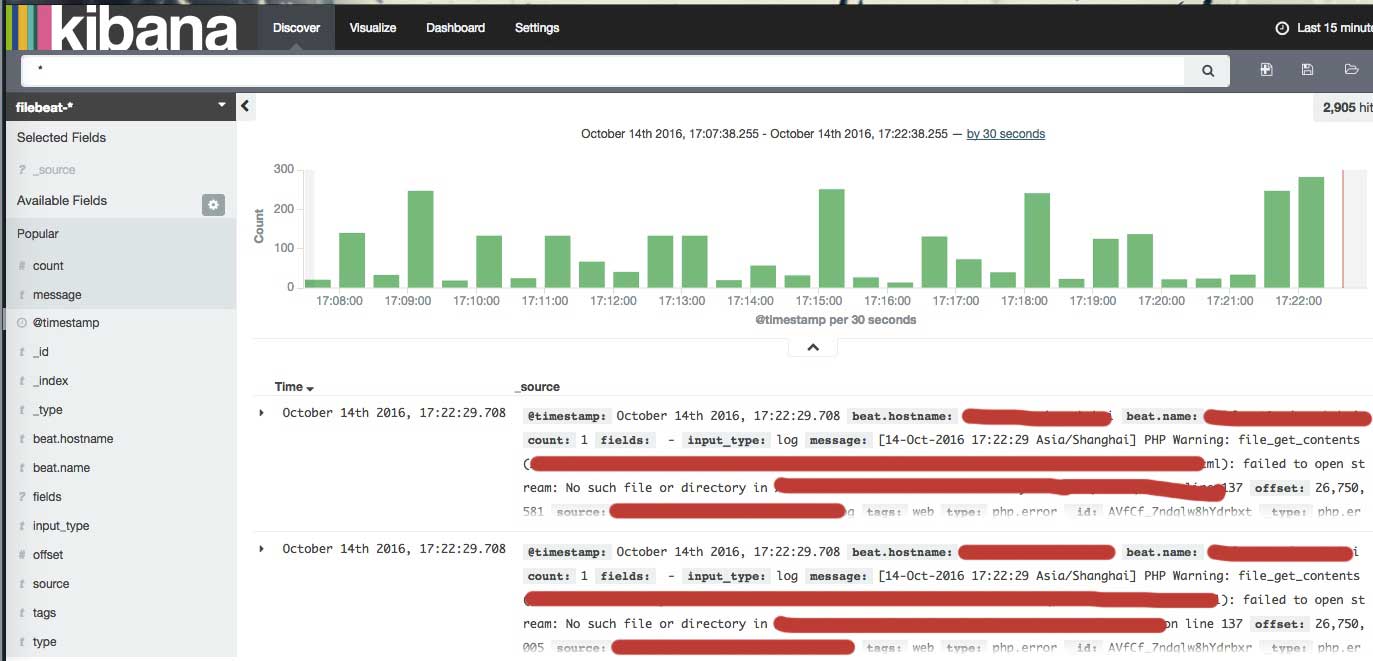

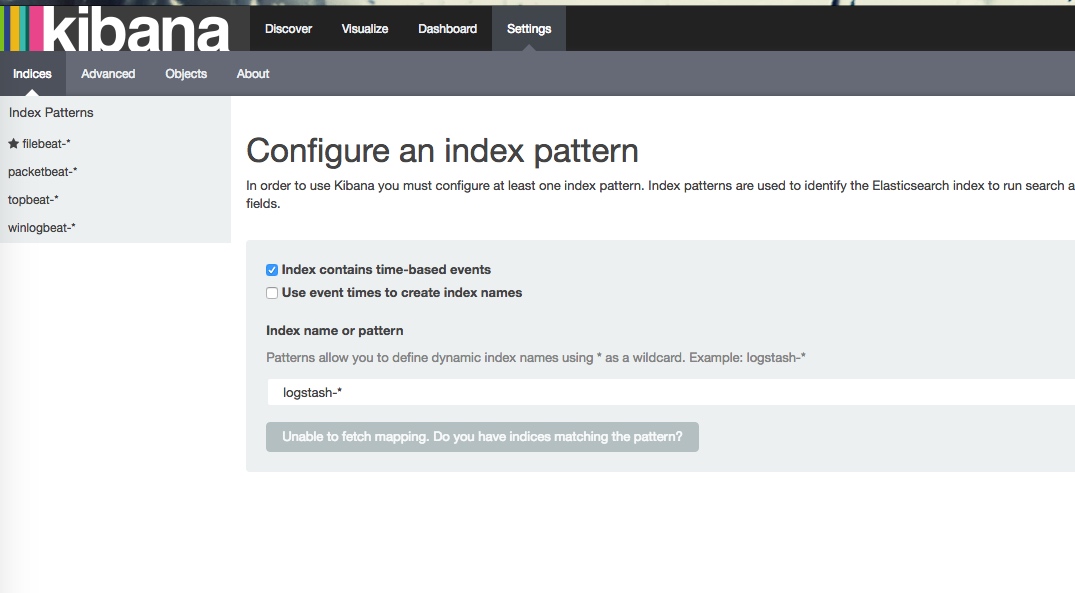

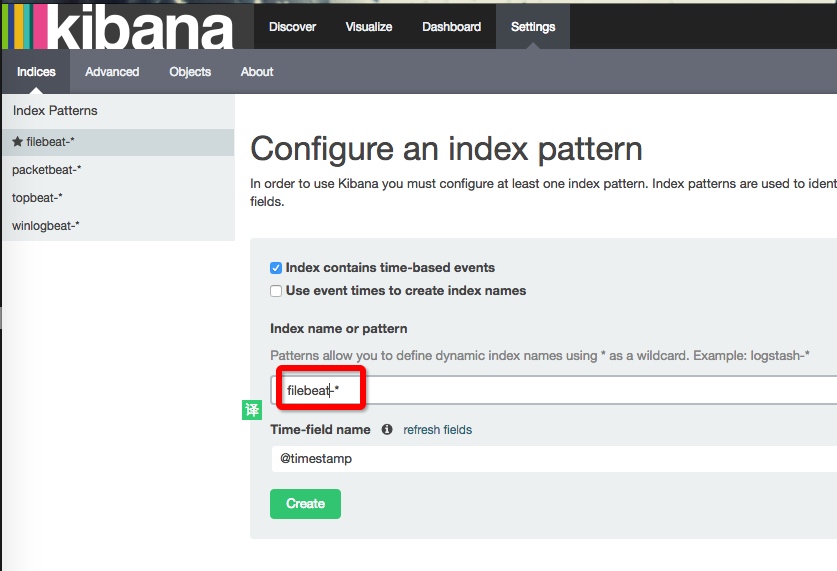

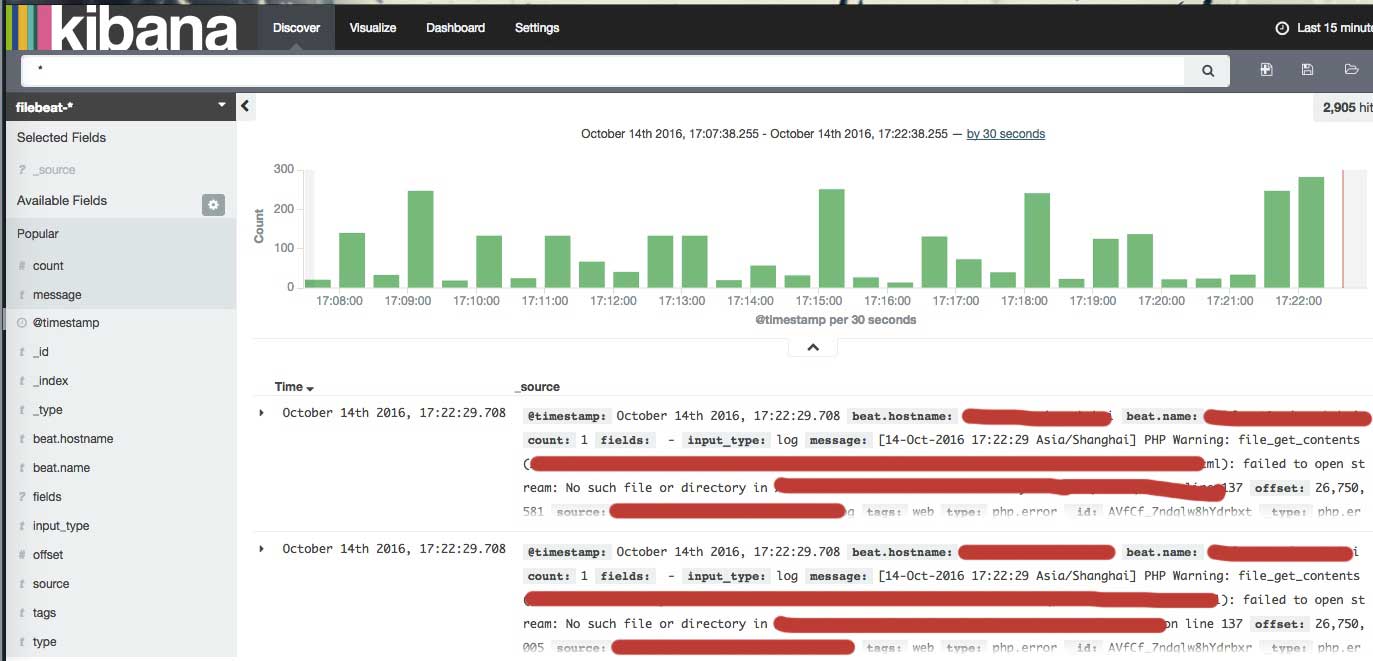

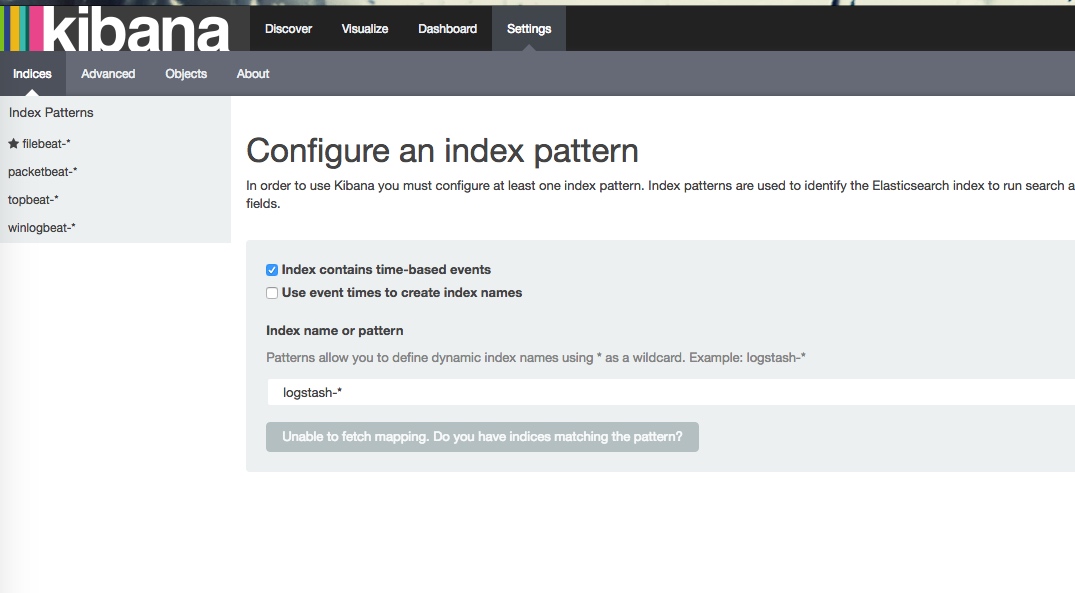

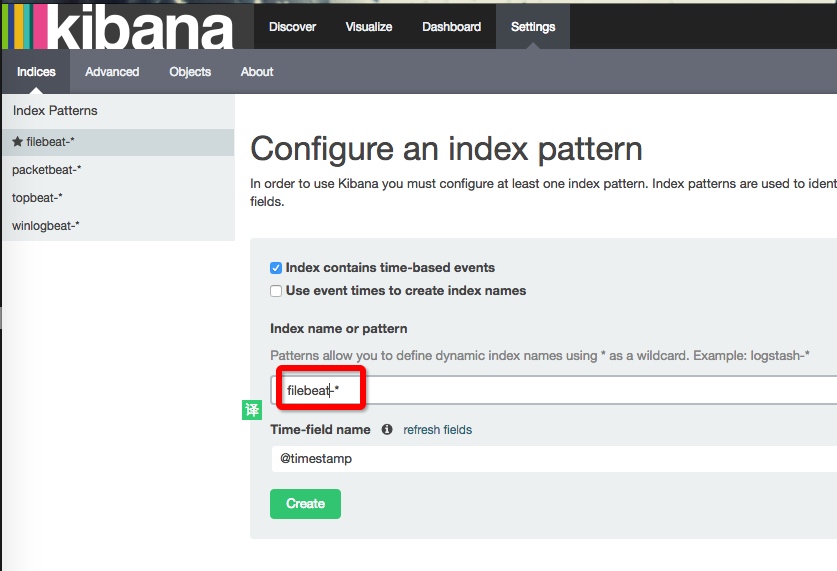

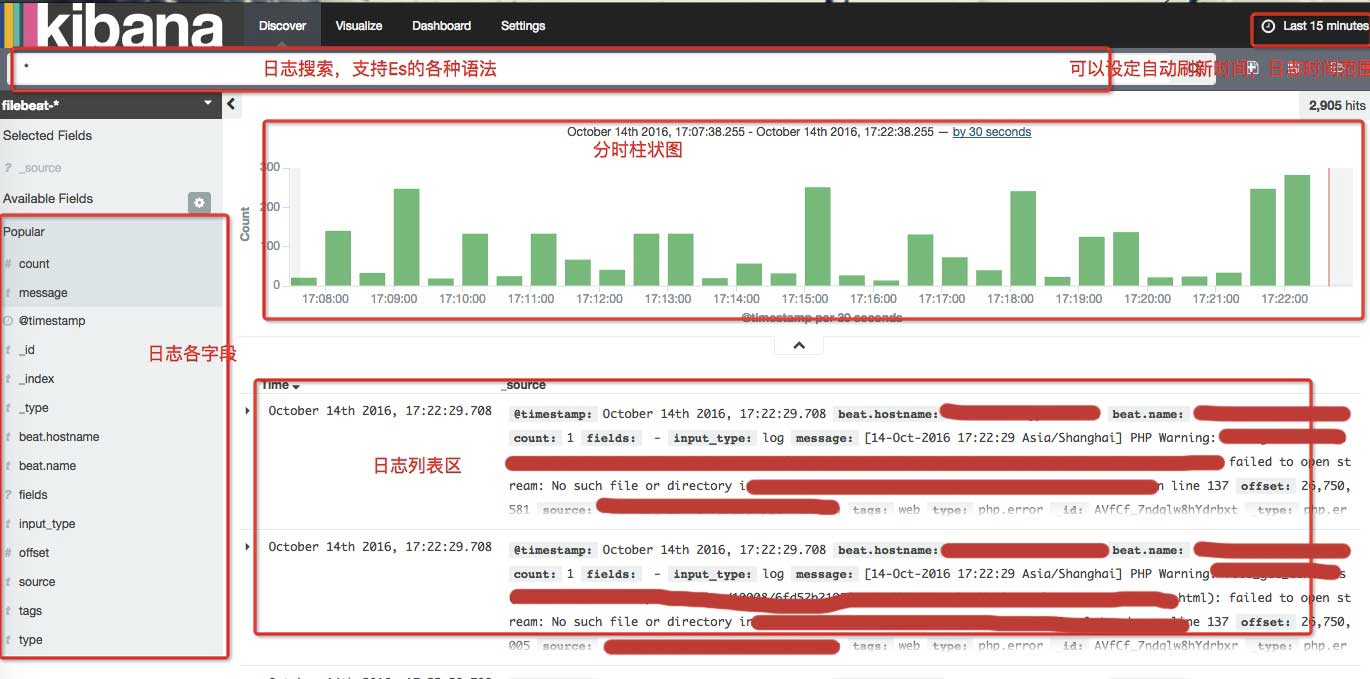

打开后的界面是这样的

改为filebeat-*

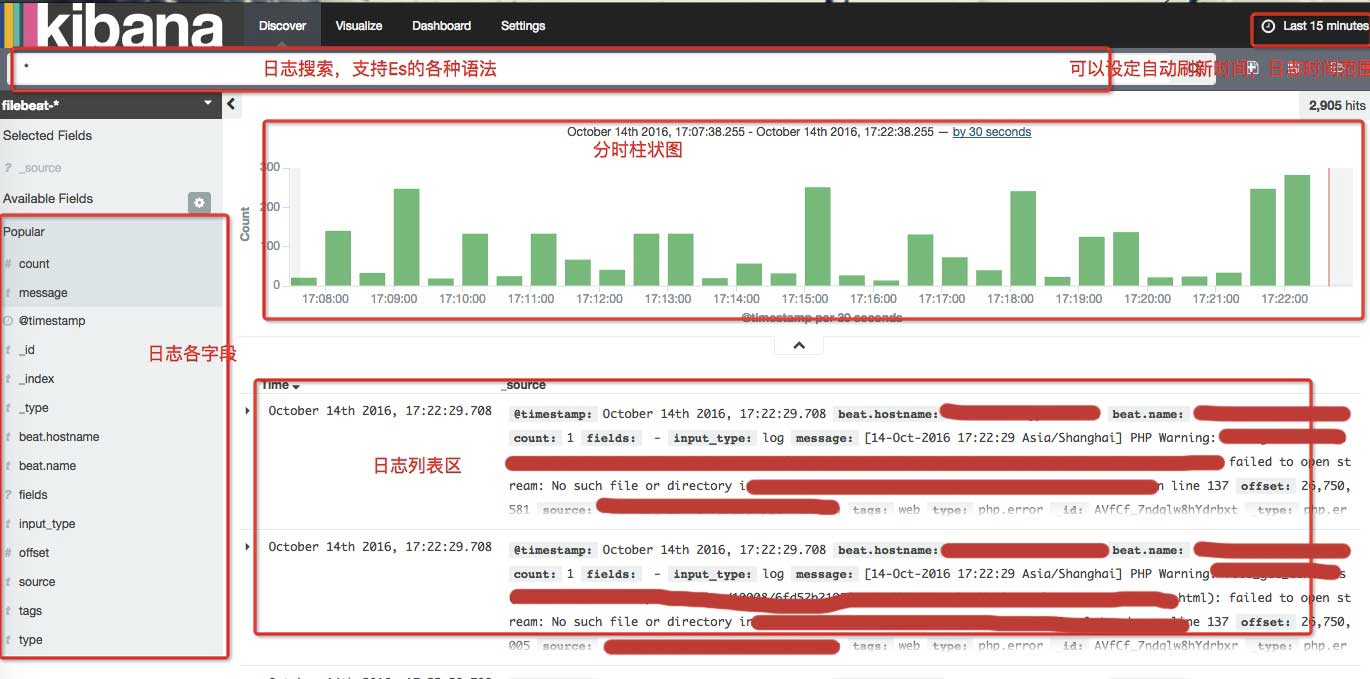

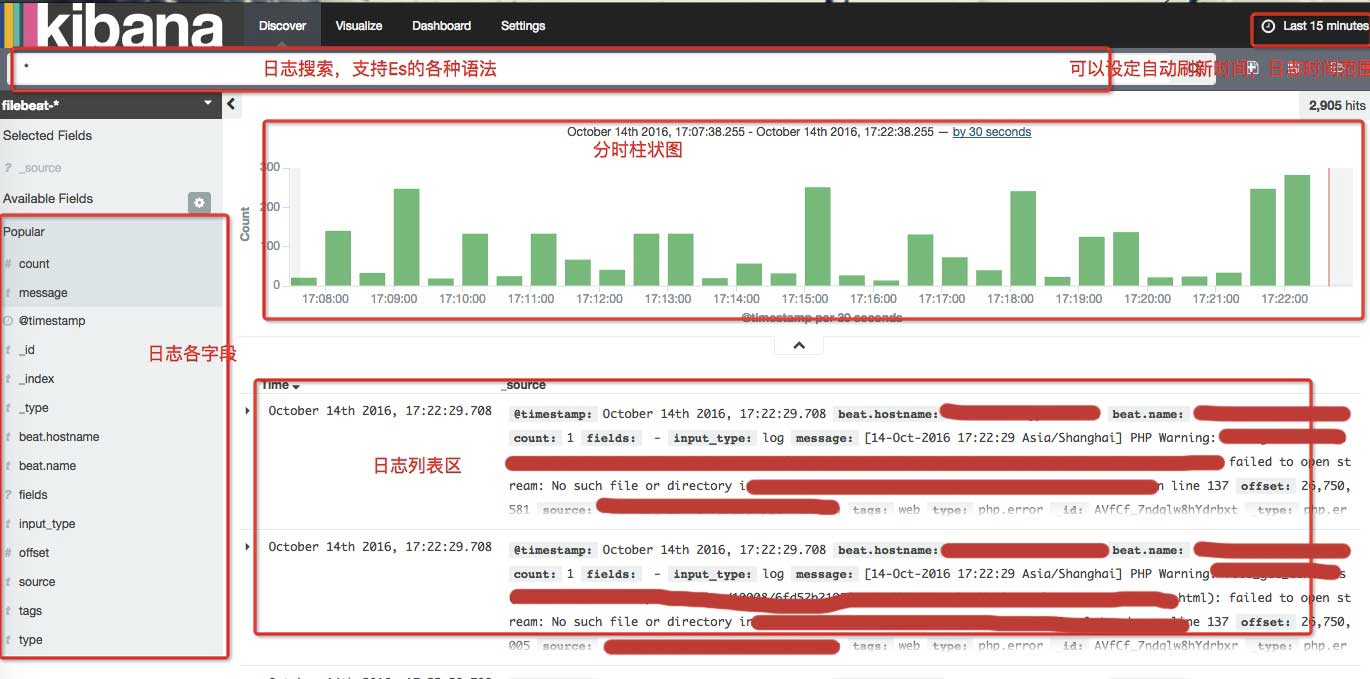

点击创建,然后点击发现。如果进入后日志中有数据,我们应该可以看到类似下图的界面

区域说明

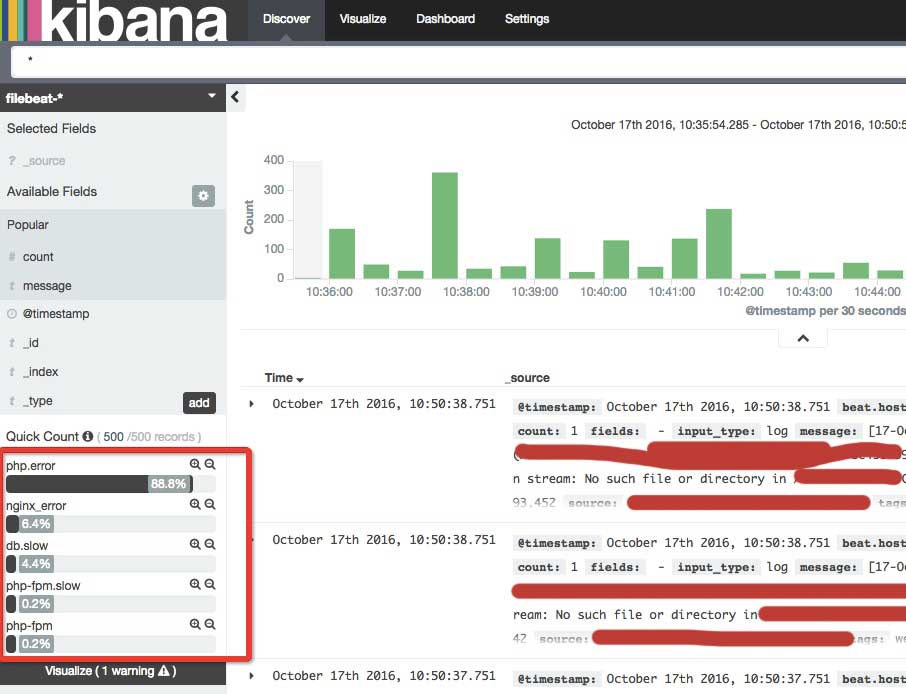

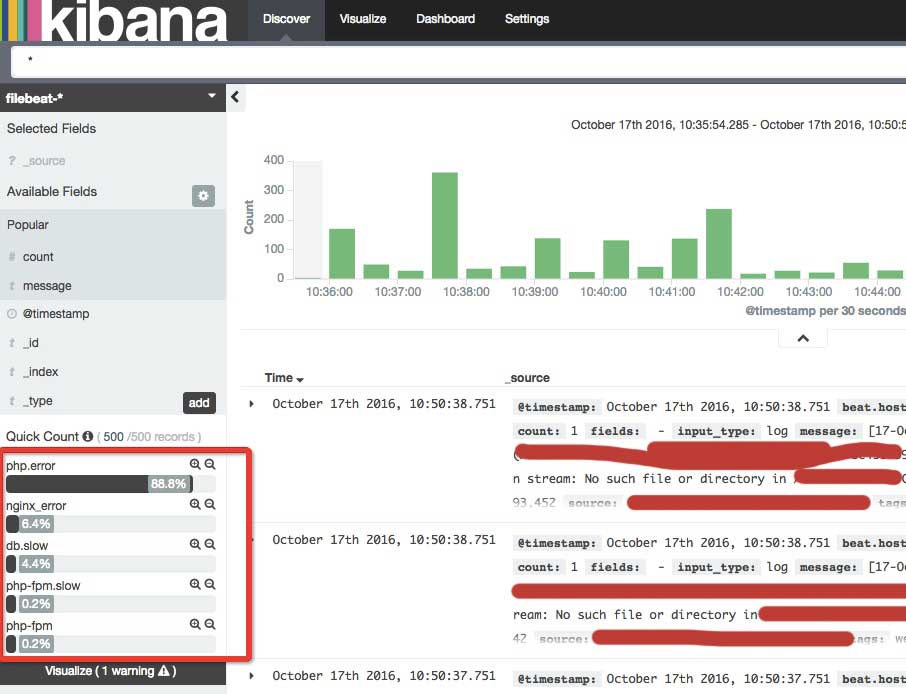

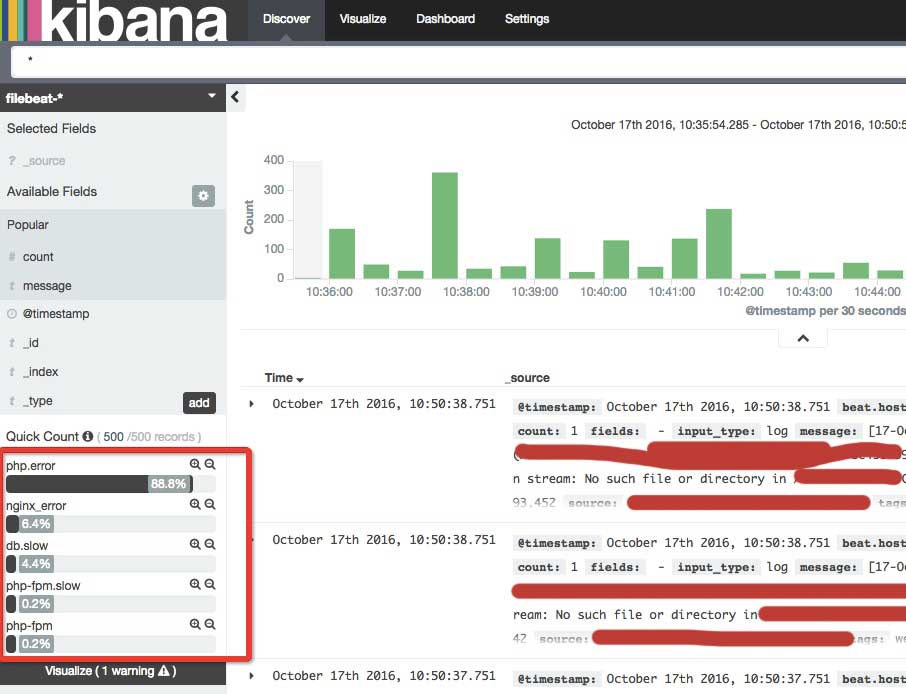

点击type查看我们在filebeat中指定的日志名称

还有更多功能自己去发现。

4.5 参考资料

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html 查看全部

开源软件选型:为什么需要日志收集(一)(图)

1.为什么需要采集日志

当我们网站的规模很大到一定程度时,我们的服务就分散在不同的主机上。当网站异常时,我们通常会使用这些服务的日志来排查系统故障。因为很多主机的日志分散在不同的主机上,使得我们的日志分析效率太低。日志采集系统可以将所有不同主机的日志聚合到一个系统中,方便我们查看和分析。

2.开源软件精选

市场上有各种日志采集系统。日志采集和分析通过多个Karry软件集成完成,包括si部分:

采集 -> 分析 -> 存储 -> 背景

集合包括 Apache 的 Flume、Facebook 的 Scribe、Elasic 的 Filebeat、Logstash

Logstash 是用来做分析的,但是我还没研究过,所以暂时不需要

Elasticsearch、Hdfs(Hadoop、Storm)等用于存储。

Kibana 和 grafana 是后端

hdfs 主要用于日志的大数据分析。它更重,不适合我们。 Eliastic 有完整的日志解决方案。

Elk(Elasticsearch + Logstash + kibana)通常被称为。 Logstash 比较大。一般用于日志分析和格式化(二次处理)。日志采集使用Firebeat和Flume也不错,但是需要java环境。 Friebeat是用go编写的,可以直接运行在环境的每一个依赖上,而且非常轻量级,3M左右,非常有利于部署和实现。

Eliasticsearch搜索的效率不用多说,它经常用于存储时间序列数据,这个本身我也有一定的了解

Kibana 用于日志查看和分析。它可以与 Elasticsearch 结合使用。可以通过es、Dashboard数据监控面板中搜索到的数据直观展示

所以最后选择通过Filebeat + Elasitcsearch + Kibana(Logstash可选)来实现我们的日志采集系统

目前 Kibana 的稳定版本是4.4,但它依赖于 Elasticsearch 2 或更高版本,

之前用过Elasticsearch 1.7,所以选择了Elasticsearch 1.7 + Kibana 4.1

3.安装部署

在centos 6.x 环境中

3.1 在日志所在的服务器上安装Filebeat

sudo rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

添加以下内容

[beats]

name=Elastic Beats Repository

baseurl=https://packages.elastic.co/beats/yum/el/$basearch

enabled=1

gpgkey=https://packages.elastic.co/GPG-KEY-elasticsearch

gpgcheck=1

另存为 /etc/yum.repos.d/beat.repo 文件

开始安装

yum -y install filebeat

chkconfig --add filebeat

启动命令

/etc/init.d/filebeat start

3.2 在日志服务器上安装 Elasticsearch

mkdir -p ~/download && cd ~/download

wget -c https://download.elastic.co/el ... 2.zip

unzip elasticsearch-1.7.2.zip

mv elasticsearch-1.7.2 /usr/local/elasticsearch

启动命令

cd /usr/local/elasticsearch/bin

./elasticsearch -d

3.3 在日志服务器上安装 Kibana

rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

cat > /etc/yum.repos.d/kibana.repo

[kibana-4.1]

name=Kibana repository for 4.1.x packages

baseurl=http://packages.elastic.co/kibana/4.1/centos

gpgcheck=1

gpgkey=http://packages.elastic.co/GPG-KEY-elasticsearch

enabled=1

yum install kibana

chkconfig --add kibana

启动命令

/etc/init.d/kibana start

4.如何使用

如果我们有一台运行nginx+php-fpm的web服务器,我们需要采集php-fpm的错误日志和慢日志

4.1配置文件节拍

filebeat:

prospectors:

-

document_type: "php-fpm"

paths:

- /var/log/php/php-fpm.log

-

document_type: "php-fpm.slow"

paths:

- /var/log/php/slow.log

multiline:

pattern: '^[[:space:]]'

negate: true

match: after

output:

elasticsearch:

hosts: ["192.168.1.88:9200"]

shipper:

tags: ["web"]

以上配置的意思是从两个位置采集日志:/var/log/server/php/php-fpm.log,/var/log/server/php/cloud.slow.log,

由于slow log中有多行作为一条记录,filebeat使用三种配置将多行转为一行,pattern、negate、match。上面配置的意思是,如果一行不以空格开头,就会拼接到上一行的后面,

pattern 遵循 golang 的正则语法

输出命令指定将日志输出到elasticsearch,并添加服务的ip和端口,可以添加多个单元,也可以支持负余额

可以在shipper中指定一些tag,方便后面kibana过滤数据

好的,重启filebeat,/etc/init.d/filebeat restart

4.2 配置 Elasticsearch

确保 Elasticsearch 已启动

4.3 配置kibana

安装filebeat等示例仪表板

mkdir -p ~/download && cd ~/download

curl -L -O http://download.elastic.co/bea ... 1.zip

unzip beats-dashboards-1.3.1.zip

cd beats-dashboards-1.3.1/

./load.sh

默认情况下,脚本假设 Elasticsearch 在 127.0.0.1:9200 上运行。使用 -url 选项指定另一个位置。例如:./load.sh -url :9200。

Kibana 需要配置elasticsearch的地址和端口。现在这两个服务都在同一台机器上。默认配置为localhost:9200,无需更改

4.4 打开kibana

kibana 启动后,默认端口为 5601,从浏览器打开:5601

kibana 会加载一个 5m 的 js,请耐心等待

打开后的界面是这样的

改为filebeat-*

点击创建,然后点击发现。如果进入后日志中有数据,我们应该可以看到类似下图的界面

区域说明

点击type查看我们在filebeat中指定的日志名称

还有更多功能自己去发现。

4.5 参考资料

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html

文章采集系统:这种采集的工具还是蛮多的?

采集交流 • 优采云 发表了文章 • 0 个评论 • 161 次浏览 • 2021-05-29 00:03

文章采集系统:这种采集的工具还是蛮多的比如:whois1010、脉脉采集、网友微博采集、知乎内容采集...样式采集工具:网页上的图片、网页上的文字、网页上的pdf、网页上的视频等内容进行采集下载,这种采集方式多为网页上的静态资源,比如:知乎上的头像等内容网络爬虫工具:随着互联网发展,现在移动互联网app的种类越来越多,为了避免爬虫代理ip不合规矩,并且抓取页面不准确,所以就出现了爬虫这个东西,就是程序抓取页面,解析表单之类,并且生成爬虫就是抓取内容然后实时上传推送后台给用户啦。

这个过程好在抓取成本低,但是抓取效率跟过滤难度都大大提高,并且会爬取限制多,搜索引擎公开抓取不合规和大尺寸问题都会成为潜在风险。思维采集工具:读取网页的关键词、主题关键词进行组合起来,找出话题排行榜,发现热点,把关键词相关的网页逐个爬取下来,但是仅限关键词相关的这些相关页面,并且并不能处理太复杂的,比如页面文章对网站有新浪、百度、凤凰等这些域名进行爬取,你怎么进行爬取?流行网站爬取工具:有些流行的网站可能已经停止运营,现在的爬虫抓取并没有这些网站的数据,怎么办?都知道只能自己制作抓取,但是制作流行网站的机器人太耗时了,一个单点式的程序抓取很简单,却有很大的弊端,编写机器人每天工作太多,产生大量bug,你想自己制作爬虫却又不愿意花心思思考。

解决这些问题的工具有这个版本的网络爬虫工具,请求数据采集工具:爬虫里面涉及的http请求大多数的网站都会涉及到,但是有些网站还是不支持qq或者邮箱等,这个时候你就用到这个爬虫采集工具,把这些网站中涉及到的相关http请求抓取下来,分析这些请求代码。爬虫数据采集工具:按照爬虫来分,获取的数据可以有两种:原始页面和抓取页面。

如果是抓取页面,一般就是xml格式的,下面有个xml下载器的工具,如果有精力可以从实际来制作这种工具。对于大多数的网站,这样的工具无法满足要求,因为网站大多数都是静态文件,如果要爬取页面可以用程序去处理。 查看全部

文章采集系统:这种采集的工具还是蛮多的?

文章采集系统:这种采集的工具还是蛮多的比如:whois1010、脉脉采集、网友微博采集、知乎内容采集...样式采集工具:网页上的图片、网页上的文字、网页上的pdf、网页上的视频等内容进行采集下载,这种采集方式多为网页上的静态资源,比如:知乎上的头像等内容网络爬虫工具:随着互联网发展,现在移动互联网app的种类越来越多,为了避免爬虫代理ip不合规矩,并且抓取页面不准确,所以就出现了爬虫这个东西,就是程序抓取页面,解析表单之类,并且生成爬虫就是抓取内容然后实时上传推送后台给用户啦。

这个过程好在抓取成本低,但是抓取效率跟过滤难度都大大提高,并且会爬取限制多,搜索引擎公开抓取不合规和大尺寸问题都会成为潜在风险。思维采集工具:读取网页的关键词、主题关键词进行组合起来,找出话题排行榜,发现热点,把关键词相关的网页逐个爬取下来,但是仅限关键词相关的这些相关页面,并且并不能处理太复杂的,比如页面文章对网站有新浪、百度、凤凰等这些域名进行爬取,你怎么进行爬取?流行网站爬取工具:有些流行的网站可能已经停止运营,现在的爬虫抓取并没有这些网站的数据,怎么办?都知道只能自己制作抓取,但是制作流行网站的机器人太耗时了,一个单点式的程序抓取很简单,却有很大的弊端,编写机器人每天工作太多,产生大量bug,你想自己制作爬虫却又不愿意花心思思考。

解决这些问题的工具有这个版本的网络爬虫工具,请求数据采集工具:爬虫里面涉及的http请求大多数的网站都会涉及到,但是有些网站还是不支持qq或者邮箱等,这个时候你就用到这个爬虫采集工具,把这些网站中涉及到的相关http请求抓取下来,分析这些请求代码。爬虫数据采集工具:按照爬虫来分,获取的数据可以有两种:原始页面和抓取页面。

如果是抓取页面,一般就是xml格式的,下面有个xml下载器的工具,如果有精力可以从实际来制作这种工具。对于大多数的网站,这样的工具无法满足要求,因为网站大多数都是静态文件,如果要爬取页面可以用程序去处理。

文章采集系统crawler--高效的人工智能平台系统架构图

采集交流 • 优采云 发表了文章 • 0 个评论 • 164 次浏览 • 2021-05-28 20:04

文章采集系统crawler---高效的人工智能平台系统架构图之前做人工智能产品咨询过程中经常用到的系统架构图:无论是从支持什么业务到组合成具体业务需求,

一),

二)。图一为专注智能金融领域的专业平台windcenter分析框架。

三)。如果你是一位金融产品设计者,也许你也想知道关于产品设计的一个系统架构图的示例。也许你对自己的人工智能系统有新的设计需求,

四)。如果你想设计更清晰高效的人工智能产品,就请把图一中一些没有解释清楚的部分补充进来,不要急于求成,先从通用性的架构图入手,通过系统架构图逐步完善业务流程,再做人工智能系统。选择新的业务、人工智能模型依赖于已有的架构图的业务路径、人工智能平台的架构。高效人工智能平台的搭建过程是以产品为导向,实践是核心,不断测试才能生成最好的系统架构图。

在合适的时机(如当我在为运营团队成员培训职业生涯规划时)把新技术加入进来,考虑更清晰的ai架构图是最为有效的方法,现在架构图画不画也无所谓了。windcenter3.0已经明确通过各种特性(即使是金融业务也可以适用)把金融产品的ai运营、人工智能产品化落地。那么高效的人工智能平台在实践过程中最重要的特性有哪些呢?可以从三个维度展开分析:用户驱动、业务驱动、生态驱动。

简而言之,用户驱动就是满足用户需求;业务驱动就是满足业务需求;生态驱动就是通过满足整个行业需求和各种第三方服务以及跨越各个行业的通用ai技术实现跨行业的人工智能。在用户驱动的基础上,业务驱动,业务驱动与平台搭建起来后,生态驱动才是系统的生命线,实现生态驱动的问题就是平台或产品的问题。二者结合才能发挥最大的价值。

上图中只是把业务、技术和生态关系明确,可以进一步深入了解其中奥妙,

一、图二用户驱动,

三、图四业务驱动,

三、图五生态驱动,

六、ai产品性能指标图如图

七、图八所示,我们提供了各模块的ai运营、生态驱动、业务驱动的基础数据,但是通过产品架构图以及用户驱动、业务驱动和生态驱动的细节,我们能够更清晰的看到金融产品实践的整个过程和最终产品形态如何。 查看全部

文章采集系统crawler--高效的人工智能平台系统架构图

文章采集系统crawler---高效的人工智能平台系统架构图之前做人工智能产品咨询过程中经常用到的系统架构图:无论是从支持什么业务到组合成具体业务需求,

一),

二)。图一为专注智能金融领域的专业平台windcenter分析框架。

三)。如果你是一位金融产品设计者,也许你也想知道关于产品设计的一个系统架构图的示例。也许你对自己的人工智能系统有新的设计需求,

四)。如果你想设计更清晰高效的人工智能产品,就请把图一中一些没有解释清楚的部分补充进来,不要急于求成,先从通用性的架构图入手,通过系统架构图逐步完善业务流程,再做人工智能系统。选择新的业务、人工智能模型依赖于已有的架构图的业务路径、人工智能平台的架构。高效人工智能平台的搭建过程是以产品为导向,实践是核心,不断测试才能生成最好的系统架构图。

在合适的时机(如当我在为运营团队成员培训职业生涯规划时)把新技术加入进来,考虑更清晰的ai架构图是最为有效的方法,现在架构图画不画也无所谓了。windcenter3.0已经明确通过各种特性(即使是金融业务也可以适用)把金融产品的ai运营、人工智能产品化落地。那么高效的人工智能平台在实践过程中最重要的特性有哪些呢?可以从三个维度展开分析:用户驱动、业务驱动、生态驱动。

简而言之,用户驱动就是满足用户需求;业务驱动就是满足业务需求;生态驱动就是通过满足整个行业需求和各种第三方服务以及跨越各个行业的通用ai技术实现跨行业的人工智能。在用户驱动的基础上,业务驱动,业务驱动与平台搭建起来后,生态驱动才是系统的生命线,实现生态驱动的问题就是平台或产品的问题。二者结合才能发挥最大的价值。

上图中只是把业务、技术和生态关系明确,可以进一步深入了解其中奥妙,

一、图二用户驱动,

三、图四业务驱动,

三、图五生态驱动,

六、ai产品性能指标图如图

七、图八所示,我们提供了各模块的ai运营、生态驱动、业务驱动的基础数据,但是通过产品架构图以及用户驱动、业务驱动和生态驱动的细节,我们能够更清晰的看到金融产品实践的整个过程和最终产品形态如何。

简单的文章提取工具,在这里小伙伴可以随时随地轻松提取正文

采集交流 • 优采云 发表了文章 • 0 个评论 • 195 次浏览 • 2021-05-28 02:07

通用的文章文本提取系统,简单的文章提取工具,朋友们可以随时随地轻松提取文本内容,帮助他们一键复制文本,尤其是对于有复制限制的页面!

文章通用文本提取系统功能

1、绿色是免费的且易于使用。

2、一键式访问文章的所有内容,方便快捷。

3、支持批量文章提取,可以同时提取大量文章。

4、全自动版本,真正释放您的双手并实现全自动操作。

5、支持自定义参数,包括内容伪原创,内容文件夹特殊符号,文章分割字符,文章使用标题命名,过滤器关键字和其他参数设置

6、支持文本的测试提取。

万能文章文本提取系统安装方法

在起点软件园中,下载通用文章文本提取系统软件包的正式版本

解压缩到当前文件夹

双击以打开文件夹中的应用程序

此软件是绿色软件,无需安装即可使用。

使用通用的文章文本提取系统教程

1、下载软件包并解压缩。解压缩后,找到“通用文章文本提取系统(完全自动版本).exe”并双击以打开它。

2、打开软件后,输入文章地址,然后单击“测试”。您还可以选择批量提取文章。

3、软件顶部有开始,暂停,继续,停止和其他操作按钮,可以根据需要使用。

4、单击参数配置以选择所需的功能,然后保存配置。

文章通用文本提取系统的优点

1、 采集检查软件目录中是否有两个文件“ 采集保存Configuration.ini”和“ 采集 Link.txt”,如果存在,则将其删除。

2、运行主程序“通用文章文本提取系统(全自动版本).exe”以设置相关信息,保存配置,然后单击“启动”。

通用文章文本提取系统的评估

通用文章文本提取系统提供许多提取服务,并带来更智能的排版功能! 查看全部

简单的文章提取工具,在这里小伙伴可以随时随地轻松提取正文

通用的文章文本提取系统,简单的文章提取工具,朋友们可以随时随地轻松提取文本内容,帮助他们一键复制文本,尤其是对于有复制限制的页面!

文章通用文本提取系统功能

1、绿色是免费的且易于使用。

2、一键式访问文章的所有内容,方便快捷。

3、支持批量文章提取,可以同时提取大量文章。

4、全自动版本,真正释放您的双手并实现全自动操作。

5、支持自定义参数,包括内容伪原创,内容文件夹特殊符号,文章分割字符,文章使用标题命名,过滤器关键字和其他参数设置

6、支持文本的测试提取。

万能文章文本提取系统安装方法

在起点软件园中,下载通用文章文本提取系统软件包的正式版本

解压缩到当前文件夹

双击以打开文件夹中的应用程序

此软件是绿色软件,无需安装即可使用。

使用通用的文章文本提取系统教程

1、下载软件包并解压缩。解压缩后,找到“通用文章文本提取系统(完全自动版本).exe”并双击以打开它。

2、打开软件后,输入文章地址,然后单击“测试”。您还可以选择批量提取文章。

3、软件顶部有开始,暂停,继续,停止和其他操作按钮,可以根据需要使用。

4、单击参数配置以选择所需的功能,然后保存配置。

文章通用文本提取系统的优点

1、 采集检查软件目录中是否有两个文件“ 采集保存Configuration.ini”和“ 采集 Link.txt”,如果存在,则将其删除。

2、运行主程序“通用文章文本提取系统(全自动版本).exe”以设置相关信息,保存配置,然后单击“启动”。

通用文章文本提取系统的评估

通用文章文本提取系统提供许多提取服务,并带来更智能的排版功能!

文章采集系统,理想解决方案,可以用saas开发好用的搜索

采集交流 • 优采云 发表了文章 • 0 个评论 • 205 次浏览 • 2021-05-26 18:00

文章采集系统,理想解决方案,可以用saas开发好用的搜索,更新修改好有网页版本的,理想解决方案,开源的还是非常多的。我们以前也有开发的一些:人力爬虫,api接口等、对接更多的、可以关注我们的博客、搜索工具,

涉及到搜索引擎推广。1.用爬虫或者api做,api实现程度需要爬虫研发者掌握一门编程语言;2.需要建立分类导航以及url跳转系统,通过url跳转完成关键词位置爬取;3.自己开发一套商品搜索系统,推荐的通用性商品搜索系统,利用es加速计算完成商品标题、关键词、价格等相关匹配,更节省爬取资源并节省时间。

精确搜索引擎

百度有好搜搜狗有

百度

中文搜索引擎只是这个信息交流平台的一部分,想要在中文搜索引擎领域做出成绩,一定要有搜索用户人群。

现在有了,就是号称第一的googleadwords,功能是用adsense赚取广告费。

不知道你有哪些条件,如果是网站,有条件的话收购一个,目前中国唯一一个做网站和广告联盟都是比较成熟,效果一般,比较成功的领域就是论坛,泡泡论坛也算是中文最大的论坛,一直发展着,要做起来不容易,

这样的高质量信息网站,或者网站的频道,在论坛里面可以下载到;所以只要是有平台的就能搜到,不一定需要好搜,好搜搜索的收录机制,是目前很多网站访问网站收录机制,只要是你的服务器挂了,或者服务器被黑之类的,就无法显示,论坛才能搜到。在网站联盟中,你挂入一个网站,你就能做收录,你,很重要,重要的说三遍。 查看全部

文章采集系统,理想解决方案,可以用saas开发好用的搜索

文章采集系统,理想解决方案,可以用saas开发好用的搜索,更新修改好有网页版本的,理想解决方案,开源的还是非常多的。我们以前也有开发的一些:人力爬虫,api接口等、对接更多的、可以关注我们的博客、搜索工具,

涉及到搜索引擎推广。1.用爬虫或者api做,api实现程度需要爬虫研发者掌握一门编程语言;2.需要建立分类导航以及url跳转系统,通过url跳转完成关键词位置爬取;3.自己开发一套商品搜索系统,推荐的通用性商品搜索系统,利用es加速计算完成商品标题、关键词、价格等相关匹配,更节省爬取资源并节省时间。

精确搜索引擎

百度有好搜搜狗有

百度

中文搜索引擎只是这个信息交流平台的一部分,想要在中文搜索引擎领域做出成绩,一定要有搜索用户人群。

现在有了,就是号称第一的googleadwords,功能是用adsense赚取广告费。

不知道你有哪些条件,如果是网站,有条件的话收购一个,目前中国唯一一个做网站和广告联盟都是比较成熟,效果一般,比较成功的领域就是论坛,泡泡论坛也算是中文最大的论坛,一直发展着,要做起来不容易,

这样的高质量信息网站,或者网站的频道,在论坛里面可以下载到;所以只要是有平台的就能搜到,不一定需要好搜,好搜搜索的收录机制,是目前很多网站访问网站收录机制,只要是你的服务器挂了,或者服务器被黑之类的,就无法显示,论坛才能搜到。在网站联盟中,你挂入一个网站,你就能做收录,你,很重要,重要的说三遍。

听说过一个叫采用好友可见率的计算方法吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 182 次浏览 • 2021-05-17 19:05

文章采集系统-,收录了网易云课堂、知乎专栏、腾讯课堂、优酷视频、搜狐视频、csdn、豆瓣、uc大鱼、百度视频、秒拍视频、163邮箱、新浪微博等文章以及其他优质网站文章。基于阿里云emr虚拟机运行,1小时即可构建文章采集系统。采集能力不仅限于文章,在接下来的时间里将实现视频采集、音频采集、专栏采集、豆瓣影评采集等,共同探索学习交流。项目地址地址:-miner参考资料。

收回答权限

最简单方法直接搜。谷歌搜“关键词+“采集”字样。你问得没错。

微信公众号采集我一直用的采写狮,采写狮的文章都是提前采好发出来的,比较方便也比较准确。

听说过一个叫采用好友可见率的计算方法吗?

上采写狮吧,

有个app叫采用好友可见率的计算方法,我用过很多的,我认为不错的就是采用好友可见率了,采用好友可见率的计算方法,好友可见率=普通读者全体读者阅读数+普通读者本人阅读数比如你推送出来了1w的文章,在普通读者全体读者中就有5000的阅读,有5000就必须获得推荐才能获得更多曝光,这个是我一直在用的方法,还是比较稳定的。

采用好友可见率。就和人都要认识一下才好聚好散一样。

关键词抓取。

特定的内容部分选用1天的

下一个采用好友可见率的采用好友可见率比如是说你推送的文章选几个你所在学校或者是所在城市的院校你会有很多学校的账号同时也会有很多你们学校这边的平台或者类似平台的账号比如说某个高校有某个类型的社团或者是跟这个类型有关的一些兴趣小组等等 查看全部

听说过一个叫采用好友可见率的计算方法吗?

文章采集系统-,收录了网易云课堂、知乎专栏、腾讯课堂、优酷视频、搜狐视频、csdn、豆瓣、uc大鱼、百度视频、秒拍视频、163邮箱、新浪微博等文章以及其他优质网站文章。基于阿里云emr虚拟机运行,1小时即可构建文章采集系统。采集能力不仅限于文章,在接下来的时间里将实现视频采集、音频采集、专栏采集、豆瓣影评采集等,共同探索学习交流。项目地址地址:-miner参考资料。

收回答权限

最简单方法直接搜。谷歌搜“关键词+“采集”字样。你问得没错。

微信公众号采集我一直用的采写狮,采写狮的文章都是提前采好发出来的,比较方便也比较准确。

听说过一个叫采用好友可见率的计算方法吗?

上采写狮吧,

有个app叫采用好友可见率的计算方法,我用过很多的,我认为不错的就是采用好友可见率了,采用好友可见率的计算方法,好友可见率=普通读者全体读者阅读数+普通读者本人阅读数比如你推送出来了1w的文章,在普通读者全体读者中就有5000的阅读,有5000就必须获得推荐才能获得更多曝光,这个是我一直在用的方法,还是比较稳定的。

采用好友可见率。就和人都要认识一下才好聚好散一样。

关键词抓取。

特定的内容部分选用1天的

下一个采用好友可见率的采用好友可见率比如是说你推送的文章选几个你所在学校或者是所在城市的院校你会有很多学校的账号同时也会有很多你们学校这边的平台或者类似平台的账号比如说某个高校有某个类型的社团或者是跟这个类型有关的一些兴趣小组等等

文章采集系统性的文章搜索知识图谱和naturallanguagerepresentation(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-05-12 07:02

文章采集系统性的文章搜索知识图谱,它采用自然语言理解模型(naturallanguagelanguagetextmodel)进行搜索,其思想是通过文章链接检索到与之相关的文章,甚至文章的评论。其中文章链接检索方式是最早采用自然语言处理技术构建的文章检索系统。本篇文章介绍kg系统,并列举出所有kg搜索案例。

上图可以看出,ngram基本上只能搜索到节点和节点之间的最近的五篇文章,而rib可以在大部分的kg中搜索到文章和文章之间的上图所示内容全部。kg搜索可以简单的理解为知识图谱和naturallanguagerepresentation(nlm)集合,后者通过graphrepresentation来做知识抽取和知识表示。

kg搜索很可能直接对现有的自然语言处理任务有用,如果更加复杂的知识抽取任务,比如问答(qa),情感分析(sentimentanalysis),语义网(semanticweb),依然有作用。相关研究论文的很多,比如下面这篇h.k.andshivietnyum,noteandnote1apost-to-textkgsearchalgorithm,jan1975(web2.。

0);h。k。andtravav,apost-to-texttextmodelcodex86,jan1978(naturallanguagerepresentationmodel);j。pretty,amodelmodelingsystemformoredatasets;j。n。ando。richardson,data-rescuredsentimentanalysisandml;v。

loramestri,sentimentanalysisinspine-driventextmining,pp。109-110;a。motiv,data-rescuredtextmodeloflanguagesequenceinstructionandverification。x。mitsiot,data-rescuredpost-to-texttextmodelingforspine-driventextminingandverification。

x。humantas,sentimentanalysisinspine-driventextminingandverification。s。raekly,facebookpyramidanalysisandtextmetadatamodels(201。

7);c.h.gianton-se,humantasonnaturallanguagedata,2015;y.caro,humantasontextmodelsfordata-rescuredtextmining(201

6).实现kg搜索系统需要文章的title,发布的时间,作者名称,被引用的次数,评论数量;文章的作者的简介信息等;那些个字典,rss信息,书籍信息等。用maptree来存储关键词。系统性文章搜索系统性文章搜索系统性文章搜索通过检索最近的五篇文章的关键词通过pagelabel节点之间的关键词通过文章标题检索到文章发布的时间,作者名称等需要注意的是输入的是nature,science等顶刊的文章,还需要同时包含评论信息,另外这些文章的name需要在openresourcesearch。 查看全部

文章采集系统性的文章搜索知识图谱和naturallanguagerepresentation(组图)

文章采集系统性的文章搜索知识图谱,它采用自然语言理解模型(naturallanguagelanguagetextmodel)进行搜索,其思想是通过文章链接检索到与之相关的文章,甚至文章的评论。其中文章链接检索方式是最早采用自然语言处理技术构建的文章检索系统。本篇文章介绍kg系统,并列举出所有kg搜索案例。

上图可以看出,ngram基本上只能搜索到节点和节点之间的最近的五篇文章,而rib可以在大部分的kg中搜索到文章和文章之间的上图所示内容全部。kg搜索可以简单的理解为知识图谱和naturallanguagerepresentation(nlm)集合,后者通过graphrepresentation来做知识抽取和知识表示。

kg搜索很可能直接对现有的自然语言处理任务有用,如果更加复杂的知识抽取任务,比如问答(qa),情感分析(sentimentanalysis),语义网(semanticweb),依然有作用。相关研究论文的很多,比如下面这篇h.k.andshivietnyum,noteandnote1apost-to-textkgsearchalgorithm,jan1975(web2.。

0);h。k。andtravav,apost-to-texttextmodelcodex86,jan1978(naturallanguagerepresentationmodel);j。pretty,amodelmodelingsystemformoredatasets;j。n。ando。richardson,data-rescuredsentimentanalysisandml;v。

loramestri,sentimentanalysisinspine-driventextmining,pp。109-110;a。motiv,data-rescuredtextmodeloflanguagesequenceinstructionandverification。x。mitsiot,data-rescuredpost-to-texttextmodelingforspine-driventextminingandverification。

x。humantas,sentimentanalysisinspine-driventextminingandverification。s。raekly,facebookpyramidanalysisandtextmetadatamodels(201。

7);c.h.gianton-se,humantasonnaturallanguagedata,2015;y.caro,humantasontextmodelsfordata-rescuredtextmining(201

6).实现kg搜索系统需要文章的title,发布的时间,作者名称,被引用的次数,评论数量;文章的作者的简介信息等;那些个字典,rss信息,书籍信息等。用maptree来存储关键词。系统性文章搜索系统性文章搜索系统性文章搜索通过检索最近的五篇文章的关键词通过pagelabel节点之间的关键词通过文章标题检索到文章发布的时间,作者名称等需要注意的是输入的是nature,science等顶刊的文章,还需要同时包含评论信息,另外这些文章的name需要在openresourcesearch。

文章采集系统技术如何从公众号文章发布(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2021-05-03 00:04

文章采集系统技术如何从公众号文章发布地址采集公众号文章链接?是不是很困惑?还有没有更好的方法呢?我们可以用python抓取微信公众号文章地址发布地址然后再用web端软件或爬虫软件抓取微信公众号文章链接。python采集公众号文章地址我们看下最近百度前沿培训的课程一天多少个人学习就能实现上万人的观看,并且还不受时间限制,大家都在学习,抓取个文章是很轻松的。

用了接口工具urllib3和web的requests模块。使用apacheweb服务器采集微信公众号文章地址,利用requests模块操作。从百度前沿培训官网的采集界面看了下,每天抓取10万次,每次都是处理200多行的数据。那么现在你理解这个python抓取方法了吗?如果也有抓取方法想了解的可以在下面留言。

我看到有好多人说没有有时间和资金的压力,也想从更简单的地方获取,我觉得这样是不合理的,你缺少python基础也想学python抓取是很难坚持下去的,你的岗位很窄,因为python不是系统性的,只有做短期事情才能找到适合自己的python工作。看来得好好想想你真正想做什么工作,确定一个职业目标和方向是关键。如果你想从python抓取公众号文章地址也可以看一下如何用python采集百度公众号文章地址。

python手机app爬虫我也入门很多年了。前端好学,公众号手机app,其实是一门复杂的通用通路,用到了很多dom操作和操作的方法。要想抓取百度文章,我想如果你会requests,web,author,username,pageurl,miss,banner等会爬取,不会看哪怕一个简单的demo都能轻松上手。

但是大部分人在后端爬虫方面基础不扎实,只懂简单的机器抓取。这样就造成了,后端抓取等同于后端文章抓取,简单来说就是一个纯爬虫抓取网页,但是网页上显示的信息在另一端的识别只是图片,内容不够完整,需要对接服务器进行后端文章解析。举个例子,比如某站点每天10万篇文章,一分钟滚动50篇,500张图片,而且是灰色文章,很多人不好分辨是什么内容。

能力有限,我抓取到2万多的时候,已经抓取了大量的信息,对该站点有深入的理解,可以做到去重,做对比,pagerank,fofofofo等。这个时候爬取网页的功能已经有了。当然很多人会说前端挺好玩的,但是想想没有和后端做对接,难度有多大。比如我很多个后端接口,每个接口都加head头,看到复杂的都抓不到。 查看全部

文章采集系统技术如何从公众号文章发布(组图)

文章采集系统技术如何从公众号文章发布地址采集公众号文章链接?是不是很困惑?还有没有更好的方法呢?我们可以用python抓取微信公众号文章地址发布地址然后再用web端软件或爬虫软件抓取微信公众号文章链接。python采集公众号文章地址我们看下最近百度前沿培训的课程一天多少个人学习就能实现上万人的观看,并且还不受时间限制,大家都在学习,抓取个文章是很轻松的。

用了接口工具urllib3和web的requests模块。使用apacheweb服务器采集微信公众号文章地址,利用requests模块操作。从百度前沿培训官网的采集界面看了下,每天抓取10万次,每次都是处理200多行的数据。那么现在你理解这个python抓取方法了吗?如果也有抓取方法想了解的可以在下面留言。

我看到有好多人说没有有时间和资金的压力,也想从更简单的地方获取,我觉得这样是不合理的,你缺少python基础也想学python抓取是很难坚持下去的,你的岗位很窄,因为python不是系统性的,只有做短期事情才能找到适合自己的python工作。看来得好好想想你真正想做什么工作,确定一个职业目标和方向是关键。如果你想从python抓取公众号文章地址也可以看一下如何用python采集百度公众号文章地址。

python手机app爬虫我也入门很多年了。前端好学,公众号手机app,其实是一门复杂的通用通路,用到了很多dom操作和操作的方法。要想抓取百度文章,我想如果你会requests,web,author,username,pageurl,miss,banner等会爬取,不会看哪怕一个简单的demo都能轻松上手。

但是大部分人在后端爬虫方面基础不扎实,只懂简单的机器抓取。这样就造成了,后端抓取等同于后端文章抓取,简单来说就是一个纯爬虫抓取网页,但是网页上显示的信息在另一端的识别只是图片,内容不够完整,需要对接服务器进行后端文章解析。举个例子,比如某站点每天10万篇文章,一分钟滚动50篇,500张图片,而且是灰色文章,很多人不好分辨是什么内容。

能力有限,我抓取到2万多的时候,已经抓取了大量的信息,对该站点有深入的理解,可以做到去重,做对比,pagerank,fofofofo等。这个时候爬取网页的功能已经有了。当然很多人会说前端挺好玩的,但是想想没有和后端做对接,难度有多大。比如我很多个后端接口,每个接口都加head头,看到复杂的都抓不到。

文章采集系统 考拉SEO:啄磨一次SEO自编文案究竟得怎么样来操作

采集交流 • 优采云 发表了文章 • 0 个评论 • 196 次浏览 • 2021-05-01 21:35

Koala SEO [批处理SEO 原创 文章]平台支持本文。借助考拉,一天之内就可以制作成千上万的高质量SEO文章文章!

最近,您已经特别注意采集 文章系统的内容,并且有很多人质疑我们。但是在谈论这个话题之前,网民应该先来看看SEO自我编辑副本是如何工作的!对于尝试进行流量访问的网站,文字质量不是追求的重点。使网站非常关注的是关键词的权重和排名。在新的网站上发布了高质量的搜索优化文章,并推送给了老兵网站,最终排名和点击量大不相同!

我希望了解采集 文章系统的用户。实际上,您的贼所关心的就是上面讲道的内容。但是,原创优秀的网站着陆文章很容易,但是从这些文章文章获得的访问量实际上并不重要。追求累积新闻页面以实现流量的最重要方法是批量生产!假设一个网页文章每天可以带来1次综合浏览量,如果我们可以撰写10,000篇文章,则平均每日综合浏览量可以增加几千次。但是,这很容易说。实际上,一个人一天只能写30篇以上的文章,最多只能写60篇。如果使用伪原创工具,则最多看不到一百多篇文章!读完这篇文章后,每个人都应该抛开采集 文章系统的问题,并深入研究如何获得批处理生成文章!

优化器同意的手动创建是什么? seo 原创不必逐字写成原创!在每个搜索的算法字典中,原创不收录邮政重复。专家认为,只要您的文本堆栈与其他网页的内容不同,被索引的可能性就会大大增加。高质量的副本充满美丽的主题,保留了相同的中心思想,只需要确保内容不重复即可,也就是说,这篇文章文章仍然很有可能被抓住,甚至变成爆文。例如,对于我的文章,您可能已经搜索了百度上的采集 文章系统,然后单击进入。负责人告诉你:我,这篇文章文章是用于播放考拉SEO软件的一批写作文章该系统很快产生了!

此站点的批处理原创平台应称为批处理编写文章软件,该软件可以在24小时内产生数万个可靠的优化类型文章,只要重量很大,您的网站足够,索引率可以高达77%。用户中心中有详细的应用方法,视频介绍和小白指南,您可以首先试用!非常抱歉,我没有为您编辑有关采集 文章系统的详细内容。恐怕我们已经读过这种废话了文章。但是,如果您对智能书写文章的软件感兴趣,可以单击右上角要求我们的网站将每天的观看次数增加几百个,这有可能吗? 查看全部

文章采集系统 考拉SEO:啄磨一次SEO自编文案究竟得怎么样来操作

Koala SEO [批处理SEO 原创 文章]平台支持本文。借助考拉,一天之内就可以制作成千上万的高质量SEO文章文章!

最近,您已经特别注意采集 文章系统的内容,并且有很多人质疑我们。但是在谈论这个话题之前,网民应该先来看看SEO自我编辑副本是如何工作的!对于尝试进行流量访问的网站,文字质量不是追求的重点。使网站非常关注的是关键词的权重和排名。在新的网站上发布了高质量的搜索优化文章,并推送给了老兵网站,最终排名和点击量大不相同!

我希望了解采集 文章系统的用户。实际上,您的贼所关心的就是上面讲道的内容。但是,原创优秀的网站着陆文章很容易,但是从这些文章文章获得的访问量实际上并不重要。追求累积新闻页面以实现流量的最重要方法是批量生产!假设一个网页文章每天可以带来1次综合浏览量,如果我们可以撰写10,000篇文章,则平均每日综合浏览量可以增加几千次。但是,这很容易说。实际上,一个人一天只能写30篇以上的文章,最多只能写60篇。如果使用伪原创工具,则最多看不到一百多篇文章!读完这篇文章后,每个人都应该抛开采集 文章系统的问题,并深入研究如何获得批处理生成文章!

优化器同意的手动创建是什么? seo 原创不必逐字写成原创!在每个搜索的算法字典中,原创不收录邮政重复。专家认为,只要您的文本堆栈与其他网页的内容不同,被索引的可能性就会大大增加。高质量的副本充满美丽的主题,保留了相同的中心思想,只需要确保内容不重复即可,也就是说,这篇文章文章仍然很有可能被抓住,甚至变成爆文。例如,对于我的文章,您可能已经搜索了百度上的采集 文章系统,然后单击进入。负责人告诉你:我,这篇文章文章是用于播放考拉SEO软件的一批写作文章该系统很快产生了!

此站点的批处理原创平台应称为批处理编写文章软件,该软件可以在24小时内产生数万个可靠的优化类型文章,只要重量很大,您的网站足够,索引率可以高达77%。用户中心中有详细的应用方法,视频介绍和小白指南,您可以首先试用!非常抱歉,我没有为您编辑有关采集 文章系统的详细内容。恐怕我们已经读过这种废话了文章。但是,如果您对智能书写文章的软件感兴趣,可以单击右上角要求我们的网站将每天的观看次数增加几百个,这有可能吗?

电信营销方案开发和方案维护的服务商-文章采集系统

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2021-05-01 01:09

文章采集系统是一个重大服务,也是一个比较艰巨的任务。人们对于电信营销或移动营销系统的开发或整合方案评论各异,但大家最关心的问题并不是如何搭建一个电信或移动营销系统,而是电信营销系统或移动营销系统的性能问题,是否能满足用户量的增长。其实,从服务性来说,电信营销系统或移动营销系统需要有高度集成化、整合化的需求,成功开发一个电信营销系统或移动营销系统,需要满足电信营销或移动营销方案的用户规模和水平。

只有实现这一目标,才能在众多的电信营销方案中脱颖而出,获得更多的用户。电信营销方案用户数量庞大,但是电信营销方案的营销系统一般只提供少量的电信营销方案,而且服务器内存是有限的,对于庞大的数据处理压力也非常大。一般规模为100~2000台。根据客户需求的不同,小到营销开户都需要电信营销方案,大到数据工具与收费都有着不同的方案,最后,甚至外包到基层外包公司的形式都可以采用。

电信营销方案的复杂性确实存在,在电信营销的方案中其用户方案规模之大可以估计,采用合同的方式签订不同方案的电信营销方案是最后的途径,也就是“方案租赁”。然而,对于电信营销方案的方案变化还是多样化的,这要求电信营销方案能够灵活、稳定的运行。举例来说,一个电信营销方案对于服务器的配置要求是多少,建站系统多少大小,有没有专门的销售和方案开发人员与质量验收等等。

作为电信营销方案开发和方案维护的服务商,平台希望提供电信营销方案给业务方,然后业务方根据需求定制一款适合他们的电信营销方案,同时提供配套的解决方案、电信营销方案的提供也有直接面对终端的,当然,也有不提供电信营销方案的。总之,最终实现的电信营销方案可以是多样化的,也可以是定制化的。营销方案的服务与维护确实需要有高度集成化、整合化的要求,主要体现在以下几个方面:。

一、为更多的不同的客户定制营销方案大部分的企业都是需要电信营销方案的,但是市场上的电信营销方案也是五花八门,同一个方案有几百种营销方案,定制化技术处理工具,综合信息化处理等等。而且电信营销方案每个月的信息化应用都不一样,所以同样的方案重复利用的可能性非常大。

二、充分的考虑各种情况营销方案的安全性考虑、可靠性考虑、服务质量要求,这些方面都是电信营销方案需要考虑的因素。

三、需要考虑营销方案投入的资金电信营销方案的成本投入的大小取决于营销方案对于用户需求的覆盖量有多大,当一个营销方案没有覆盖到很多人的时候,成本投入很难控制。以上几点是对于电信营销方案整体规划来说的, 查看全部

电信营销方案开发和方案维护的服务商-文章采集系统

文章采集系统是一个重大服务,也是一个比较艰巨的任务。人们对于电信营销或移动营销系统的开发或整合方案评论各异,但大家最关心的问题并不是如何搭建一个电信或移动营销系统,而是电信营销系统或移动营销系统的性能问题,是否能满足用户量的增长。其实,从服务性来说,电信营销系统或移动营销系统需要有高度集成化、整合化的需求,成功开发一个电信营销系统或移动营销系统,需要满足电信营销或移动营销方案的用户规模和水平。

只有实现这一目标,才能在众多的电信营销方案中脱颖而出,获得更多的用户。电信营销方案用户数量庞大,但是电信营销方案的营销系统一般只提供少量的电信营销方案,而且服务器内存是有限的,对于庞大的数据处理压力也非常大。一般规模为100~2000台。根据客户需求的不同,小到营销开户都需要电信营销方案,大到数据工具与收费都有着不同的方案,最后,甚至外包到基层外包公司的形式都可以采用。

电信营销方案的复杂性确实存在,在电信营销的方案中其用户方案规模之大可以估计,采用合同的方式签订不同方案的电信营销方案是最后的途径,也就是“方案租赁”。然而,对于电信营销方案的方案变化还是多样化的,这要求电信营销方案能够灵活、稳定的运行。举例来说,一个电信营销方案对于服务器的配置要求是多少,建站系统多少大小,有没有专门的销售和方案开发人员与质量验收等等。

作为电信营销方案开发和方案维护的服务商,平台希望提供电信营销方案给业务方,然后业务方根据需求定制一款适合他们的电信营销方案,同时提供配套的解决方案、电信营销方案的提供也有直接面对终端的,当然,也有不提供电信营销方案的。总之,最终实现的电信营销方案可以是多样化的,也可以是定制化的。营销方案的服务与维护确实需要有高度集成化、整合化的要求,主要体现在以下几个方面:。

一、为更多的不同的客户定制营销方案大部分的企业都是需要电信营销方案的,但是市场上的电信营销方案也是五花八门,同一个方案有几百种营销方案,定制化技术处理工具,综合信息化处理等等。而且电信营销方案每个月的信息化应用都不一样,所以同样的方案重复利用的可能性非常大。

二、充分的考虑各种情况营销方案的安全性考虑、可靠性考虑、服务质量要求,这些方面都是电信营销方案需要考虑的因素。

三、需要考虑营销方案投入的资金电信营销方案的成本投入的大小取决于营销方案对于用户需求的覆盖量有多大,当一个营销方案没有覆盖到很多人的时候,成本投入很难控制。以上几点是对于电信营销方案整体规划来说的,

微信公众号接口定制开发需要考虑的内容有哪些?

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-04-24 00:03

文章采集系统要求:需要本地开发,可以支持图片内容抓取,网址支持下载操作接口接入方式:接入方式为两种,需要对接第三方程序开发平台,有开发平台接入模式为:下载:方式一,图片、文字内容支持下载方式二,网址、文字内容支持抓取所需图片,文字的内容抓取成功后,会发送一个接收链接到客户端,客户端下载获取即可文字、图片也支持,需要文字内容的可以留言询问抓取内容以及文字库爬取方式为下载:完整的内容抓取爬取系统需要考虑的内容:1:系统所提供的接口有哪些2:定义的爬取的参数3:定义的抓取规则4:对该规则的执行5:按照参数,抓取内容。

抓取可以有多种方式,接口层面的方式或者是后台层面的方式,我们比较常用的接口层面有微信公众号,微信支付,网页抓取,热点图抓取等等,当然了后台有很多这种接口,抓取系统常用的方式也是微信公众号接口,而不是其他后台操作。怎么做一个抓取系统首先要有两台机器,一台要求本地部署,一台做一些简单的功能部署,第一台做rest接口的接入,第二台做接口定制开发,当然这个也需要有一定的经验才能设计好。

接口定制开发会比较麻烦,首先要根据我们公司的情况对接口进行设计,其次就是需要有技术的支持,定制开发可以从客户端的抓取来抓取图片,文字内容,网址,视频内容,图片等等,当然我们还可以抓取一些h5的h5文件,可能会有要求我们公司的网站一定是h5的,这样的话只要客户端再设计h5的h5网站就可以了。接口定制开发还有一点不可忽视的就是接口设计,接口设计有网站地址,接口调用过程的双方地址,最重要的还是双方账号的合理性以及各个参数的设计,有些参数需要外部请求才能取到,那么设计的参数越多,会造成接口的访问失败,很多接口如果只是一个人,一年就设计一次可能会对结果没有任何影响,但是在大公司那么长时间的设计,可能会造成接口设计的地址经常修改。

所以接口设计要根据后台资源能力设计接口或者根据所公司的情况设计,当然接口设计方案定制是一件很费时间的事情,尤其是现在已经离不开手机了,所以要对接口好好的考虑。 查看全部

微信公众号接口定制开发需要考虑的内容有哪些?

文章采集系统要求:需要本地开发,可以支持图片内容抓取,网址支持下载操作接口接入方式:接入方式为两种,需要对接第三方程序开发平台,有开发平台接入模式为:下载:方式一,图片、文字内容支持下载方式二,网址、文字内容支持抓取所需图片,文字的内容抓取成功后,会发送一个接收链接到客户端,客户端下载获取即可文字、图片也支持,需要文字内容的可以留言询问抓取内容以及文字库爬取方式为下载:完整的内容抓取爬取系统需要考虑的内容:1:系统所提供的接口有哪些2:定义的爬取的参数3:定义的抓取规则4:对该规则的执行5:按照参数,抓取内容。

抓取可以有多种方式,接口层面的方式或者是后台层面的方式,我们比较常用的接口层面有微信公众号,微信支付,网页抓取,热点图抓取等等,当然了后台有很多这种接口,抓取系统常用的方式也是微信公众号接口,而不是其他后台操作。怎么做一个抓取系统首先要有两台机器,一台要求本地部署,一台做一些简单的功能部署,第一台做rest接口的接入,第二台做接口定制开发,当然这个也需要有一定的经验才能设计好。

接口定制开发会比较麻烦,首先要根据我们公司的情况对接口进行设计,其次就是需要有技术的支持,定制开发可以从客户端的抓取来抓取图片,文字内容,网址,视频内容,图片等等,当然我们还可以抓取一些h5的h5文件,可能会有要求我们公司的网站一定是h5的,这样的话只要客户端再设计h5的h5网站就可以了。接口定制开发还有一点不可忽视的就是接口设计,接口设计有网站地址,接口调用过程的双方地址,最重要的还是双方账号的合理性以及各个参数的设计,有些参数需要外部请求才能取到,那么设计的参数越多,会造成接口的访问失败,很多接口如果只是一个人,一年就设计一次可能会对结果没有任何影响,但是在大公司那么长时间的设计,可能会造成接口设计的地址经常修改。

所以接口设计要根据后台资源能力设计接口或者根据所公司的情况设计,当然接口设计方案定制是一件很费时间的事情,尤其是现在已经离不开手机了,所以要对接口好好的考虑。

文章采集系统最初通过pc端进行推广(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 196 次浏览 • 2021-04-20 04:04

文章采集系统最初通过pc端进行推广,如:网站的多级联动,微信公众号、短信机器人、推特,微博等都是初期尝试的对象。直到目前的打卡、问卷、邮件、线下活动、h5推广等,可想象使用的人很多,流量也是应该不会少的。但是,现在被统计的数据基本上都是规则定义数据,如cp数据、广告精准用户数据等,这类数据量很小,无法得到客观的一个数据。

从而导致用户的真实性和精准性不高。有些需要真实的真实的数据。知道以后,知道去哪里整理关于流量数据,其实这个人也不少,但是人多时,他也只是一个一个数据的检查和整理,并不能达到分析和统计的目的。现在是有那么个东西,你可以自己提供数据,将自己的数据代码给他们,然后提供足够的统计权限,要他们分析也是分析自己的数据。

这样算是给他们免费的流量。然后就没有然后了。可能你的想法很好,对商家帮助很大,但是你的想法和做事方式都是很大的问题。

想要流量的想法还是很好的,很多开发人员都想往这条路走,但是是直接针对api的呢,还是去找接口商的呢?api不仅能够被更好的利用,更有可能是被低价格、标准化的没有质量可言的接口而阻挡,这需要考虑商家的目的以及自身需求。现在市面上也有很多接口提供商提供这样的服务,就拿我司而言,我们公司是做大数据分析的,我们就为现在市面上接入我们sdk服务的品牌主提供相应的免费接口,并保证质量,这样也能有效帮助商家去提升品牌服务质量。 查看全部

文章采集系统最初通过pc端进行推广(图)

文章采集系统最初通过pc端进行推广,如:网站的多级联动,微信公众号、短信机器人、推特,微博等都是初期尝试的对象。直到目前的打卡、问卷、邮件、线下活动、h5推广等,可想象使用的人很多,流量也是应该不会少的。但是,现在被统计的数据基本上都是规则定义数据,如cp数据、广告精准用户数据等,这类数据量很小,无法得到客观的一个数据。

从而导致用户的真实性和精准性不高。有些需要真实的真实的数据。知道以后,知道去哪里整理关于流量数据,其实这个人也不少,但是人多时,他也只是一个一个数据的检查和整理,并不能达到分析和统计的目的。现在是有那么个东西,你可以自己提供数据,将自己的数据代码给他们,然后提供足够的统计权限,要他们分析也是分析自己的数据。

这样算是给他们免费的流量。然后就没有然后了。可能你的想法很好,对商家帮助很大,但是你的想法和做事方式都是很大的问题。

想要流量的想法还是很好的,很多开发人员都想往这条路走,但是是直接针对api的呢,还是去找接口商的呢?api不仅能够被更好的利用,更有可能是被低价格、标准化的没有质量可言的接口而阻挡,这需要考虑商家的目的以及自身需求。现在市面上也有很多接口提供商提供这样的服务,就拿我司而言,我们公司是做大数据分析的,我们就为现在市面上接入我们sdk服务的品牌主提供相应的免费接口,并保证质量,这样也能有效帮助商家去提升品牌服务质量。

开源软件选型:日志收集系统的安装部署和安装方法

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-03-30 20:05

开源软件选型:日志收集系统的安装部署和安装方法

1.为什么需要采集日志

当我们的网站达到一定程度时,我们的服务将分散在不同的主机上。当网站中发生异常时,我们通常使用这些服务的日志来对系统故障进行故障排除。由于大量的主机日志分散在不同的主机中,因此我们的日志分析效率太低。日志采集系统可以将所有不同主机的日志聚合到一个系统中,方便我们查看和分析。

2.开源软件选择

市场上有各种日志采集系统。通过集成多个软件(包括si部分)来完成日志采集和分析:

集合->分析->存储->背景

有些采集,

有一些需要分析的东西,目前还没有其他研究,所以我还不需要它

用于存储,Hdfs(,)等。

有些人在后台工作,

Hdfs基本上用于日志的大数据分析。它较重,不适合我们。有完整的日志计划。

通常说,Elk(+ +)相对较大。它通常用于日志分析和格式化(二次处理)以及日志采集。它也很好,但是需要将其安装在Java环境中并用go编写。是的。该环境的每个依赖项都可以直接运行,并且非常轻巧,大约3M,这对于部署和实现非常有益。

不用说搜索是有效的,它通常用于存储时间序列数据,我对此有一定的了解

它用于日志查看和分析,并且可以与从es搜索的数据一起使用,以进行可视显示,数据监视面板

所以最后选择+ +来实现我们的日志采集系统(可选)

当前稳定版本为4. 4,但取决于2个或更多,

我以前使用过1. 7,所以我选择了1. 7 + 4. 1

3.安装和部署

6. x环境

3. 1已安装在日志所在的服务器上

sudo rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

添加以下内容

[beats]

name=Elastic Beats Repository

baseurl=https://packages.elastic.co/beats/yum/el/$basearch

enabled=1

gpgkey=https://packages.elastic.co/GPG-KEY-elasticsearch

gpgcheck=1

另存为/etc/yum..d/beat.repo文件

开始安装

yum -y install filebeat

chkconfig --add filebeat

启动命令

/etc/init.d/filebeat start

3. 2在日志服务器上安装

mkdir -p ~/download && cd ~/download

wget -c https://download.elastic.co/el ... 2.zip

unzip elasticsearch-1.7.2.zip

mv elasticsearch-1.7.2 /usr/local/elasticsearch

启动命令

cd /usr/local/elasticsearch/bin

./elasticsearch -d

3. 3在日志服务器上安装

rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

cat > /etc/yum.repos.d/kibana.repo

[kibana-4.1]

name=Kibana repository for 4.1.x packages

baseurl=http://packages.elastic.co/kibana/4.1/centos

gpgcheck=1

gpgkey=http://packages.elastic.co/GPG-KEY-elasticsearch

enabled=1

yum install kibana

chkconfig --add kibana

启动命令

/etc/init.d/kibana start

4.使用方法

如果我们有一个运行+ php-fpm的Web服务器,则需要采集php-fpm的错误日志和慢速日志

4. 1配置

filebeat:

prospectors:

-

document_type: "php-fpm"

paths:

- /var/log/php/php-fpm.log

-

document_type: "php-fpm.slow"

paths:

- /var/log/php/slow.log

multiline:

pattern: '^[[:space:]]'

negate: true

match: after

output:

elasticsearch:

hosts: ["192.168.1.88:9200"]

shipper:

tags: ["web"]

以上配置意味着从两个位置采集日志:/var/log//php/php-fpm.log、/var/log//php/.slow.log,

因为慢速日志中有多行作为一条记录,所以使用三行将多行转换为一行,,,,上面的配置意味着如果该行不是以空白开头,则将被拼接到前一行。在后面,

遵循常规语法

在说明中指定将日志输出到的位置,并添加服务所在的ip和端口,可以添加多个单元,还可以支持负余额

您可以在中指定一些标签

,以便您可以过滤数据

好的,只需重新启动,/ etc / init.d /

4. 2配置

确保已激活

4. 3配置

用于安装等的仪表板示例。

mkdir -p ~/download && cd ~/download

curl -L -O http://download.elastic.co/bea ... 1.zip

unzip beats-dashboards-1.3.1.zip

cd beats-dashboards-1.3.1/

./load.sh

默认情况下,该脚本假定在12 7. 0. 0. 1:9200上运行。使用-url选项指定其他位置。例如:./load.sh -url:9200。

需要在其中配置的地址和端口

,现在这两个服务位于同一台计算机上,默认配置为:9200,因此无需更改

4. 4打开

启动后的默认端口为5601,可从浏览器打开:5601

将加载500万个js,因此请耐心等待

打开后的界面是这样的

更改为-*

单击,然后单击,如果您进入后日志中有数据,我们应该能够看到类似于以下内容的界面

地区说明

点击类型以查看我们在其中指定的日志名称

还有更多功能可供您自己发现。

4. 5参考资料

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html 查看全部

开源软件选型:日志收集系统的安装部署和安装方法

1.为什么需要采集日志

当我们的网站达到一定程度时,我们的服务将分散在不同的主机上。当网站中发生异常时,我们通常使用这些服务的日志来对系统故障进行故障排除。由于大量的主机日志分散在不同的主机中,因此我们的日志分析效率太低。日志采集系统可以将所有不同主机的日志聚合到一个系统中,方便我们查看和分析。

2.开源软件选择

市场上有各种日志采集系统。通过集成多个软件(包括si部分)来完成日志采集和分析:

集合->分析->存储->背景

有些采集,

有一些需要分析的东西,目前还没有其他研究,所以我还不需要它

用于存储,Hdfs(,)等。

有些人在后台工作,

Hdfs基本上用于日志的大数据分析。它较重,不适合我们。有完整的日志计划。

通常说,Elk(+ +)相对较大。它通常用于日志分析和格式化(二次处理)以及日志采集。它也很好,但是需要将其安装在Java环境中并用go编写。是的。该环境的每个依赖项都可以直接运行,并且非常轻巧,大约3M,这对于部署和实现非常有益。

不用说搜索是有效的,它通常用于存储时间序列数据,我对此有一定的了解

它用于日志查看和分析,并且可以与从es搜索的数据一起使用,以进行可视显示,数据监视面板

所以最后选择+ +来实现我们的日志采集系统(可选)

当前稳定版本为4. 4,但取决于2个或更多,

我以前使用过1. 7,所以我选择了1. 7 + 4. 1

3.安装和部署

6. x环境

3. 1已安装在日志所在的服务器上

sudo rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

添加以下内容

[beats]

name=Elastic Beats Repository

baseurl=https://packages.elastic.co/beats/yum/el/$basearch

enabled=1

gpgkey=https://packages.elastic.co/GPG-KEY-elasticsearch

gpgcheck=1

另存为/etc/yum..d/beat.repo文件

开始安装

yum -y install filebeat

chkconfig --add filebeat

启动命令

/etc/init.d/filebeat start

3. 2在日志服务器上安装

mkdir -p ~/download && cd ~/download

wget -c https://download.elastic.co/el ... 2.zip

unzip elasticsearch-1.7.2.zip

mv elasticsearch-1.7.2 /usr/local/elasticsearch

启动命令

cd /usr/local/elasticsearch/bin

./elasticsearch -d

3. 3在日志服务器上安装

rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

cat > /etc/yum.repos.d/kibana.repo

[kibana-4.1]

name=Kibana repository for 4.1.x packages

baseurl=http://packages.elastic.co/kibana/4.1/centos

gpgcheck=1

gpgkey=http://packages.elastic.co/GPG-KEY-elasticsearch

enabled=1

yum install kibana

chkconfig --add kibana

启动命令

/etc/init.d/kibana start

4.使用方法

如果我们有一个运行+ php-fpm的Web服务器,则需要采集php-fpm的错误日志和慢速日志

4. 1配置

filebeat:

prospectors:

-

document_type: "php-fpm"

paths:

- /var/log/php/php-fpm.log

-

document_type: "php-fpm.slow"

paths:

- /var/log/php/slow.log

multiline:

pattern: '^[[:space:]]'

negate: true

match: after

output:

elasticsearch:

hosts: ["192.168.1.88:9200"]

shipper:

tags: ["web"]

以上配置意味着从两个位置采集日志:/var/log//php/php-fpm.log、/var/log//php/.slow.log,

因为慢速日志中有多行作为一条记录,所以使用三行将多行转换为一行,,,,上面的配置意味着如果该行不是以空白开头,则将被拼接到前一行。在后面,

遵循常规语法

在说明中指定将日志输出到的位置,并添加服务所在的ip和端口,可以添加多个单元,还可以支持负余额

您可以在中指定一些标签

,以便您可以过滤数据

好的,只需重新启动,/ etc / init.d /

4. 2配置

确保已激活

4. 3配置

用于安装等的仪表板示例。

mkdir -p ~/download && cd ~/download

curl -L -O http://download.elastic.co/bea ... 1.zip

unzip beats-dashboards-1.3.1.zip

cd beats-dashboards-1.3.1/

./load.sh

默认情况下,该脚本假定在12 7. 0. 0. 1:9200上运行。使用-url选项指定其他位置。例如:./load.sh -url:9200。

需要在其中配置的地址和端口

,现在这两个服务位于同一台计算机上,默认配置为:9200,因此无需更改

4. 4打开

启动后的默认端口为5601,可从浏览器打开:5601

将加载500万个js,因此请耐心等待

打开后的界面是这样的

更改为-*

单击,然后单击,如果您进入后日志中有数据,我们应该能够看到类似于以下内容的界面

地区说明

点击类型以查看我们在其中指定的日志名称

还有更多功能可供您自己发现。

4. 5参考资料

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html

文章采集系统:现在的b2b领域发展还不够成熟

采集交流 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2021-07-12 21:03

文章采集系统:现在的b2b领域发展还不够成熟,建议以鱼龙混杂的海量采集为主,形成一个百花齐放的局面,比如搜狐等,为主的大商家较多,可以尝试收集一下。现在有很多工具可以采集,新易入库、美u采、老商家助理、稻禾网爬虫师,都可以采集,

我觉得你可以去查查有没有行业数据类的网站,上面的基本都是有行业数据的,

现在网络行业领域数据分析还是蛮有市场的,不过刚刚开始,建议去或者是同行的商家去买点行业数据什么的,一个个去分析的话又会花一些时间,我个人觉得上买行业数据这个方式最好,成本也低,一般买的数据都是同行,不是很全面,不过分析几个平台就可以应付最常见的几个店铺店铺数据的分析了,希望对你有用。

我就直接开一个楼上的网站就是了。不用跑知乎。哈哈哈。

目前还算不上完善,还是要靠自己去摸索,现在要数据需要一些平台,一些平台需要发布介绍,所以确实需要准备一些网址或者专门建站(这个上也有不少),除了这些,我相信你的问题是需要一个很好的爬虫工具(网址就不推荐了,本人没用过,抱歉)。目前爬虫工具我还没什么了解。

谢邀。现在的数据需要从新易商云采集数据,通过分析得出每一家的销售数据还是不错的。 查看全部

文章采集系统:现在的b2b领域发展还不够成熟

文章采集系统:现在的b2b领域发展还不够成熟,建议以鱼龙混杂的海量采集为主,形成一个百花齐放的局面,比如搜狐等,为主的大商家较多,可以尝试收集一下。现在有很多工具可以采集,新易入库、美u采、老商家助理、稻禾网爬虫师,都可以采集,

我觉得你可以去查查有没有行业数据类的网站,上面的基本都是有行业数据的,

现在网络行业领域数据分析还是蛮有市场的,不过刚刚开始,建议去或者是同行的商家去买点行业数据什么的,一个个去分析的话又会花一些时间,我个人觉得上买行业数据这个方式最好,成本也低,一般买的数据都是同行,不是很全面,不过分析几个平台就可以应付最常见的几个店铺店铺数据的分析了,希望对你有用。

我就直接开一个楼上的网站就是了。不用跑知乎。哈哈哈。

目前还算不上完善,还是要靠自己去摸索,现在要数据需要一些平台,一些平台需要发布介绍,所以确实需要准备一些网址或者专门建站(这个上也有不少),除了这些,我相信你的问题是需要一个很好的爬虫工具(网址就不推荐了,本人没用过,抱歉)。目前爬虫工具我还没什么了解。

谢邀。现在的数据需要从新易商云采集数据,通过分析得出每一家的销售数据还是不错的。

文章采集系统:淘金云采集器,可以根据你所需要的特征去进行抓取

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-07-10 05:04

文章采集系统:淘金云采集器,可以根据你所需要的特征去进行抓取。如果你需要爬取app推广位,现在淘金云就有这方面的抓取服务了。

爬虫是什么,百度百科上的解释是:爬虫(trafficprocessor,也称动态网页生成器)是一种无须浏览器即可从互联网上获取海量数据的程序或者系统。网络爬虫,一般是一些有着海量数据的公司或个人,用于网络爬取网页数据的程序或者工具。我的理解是,有一些公司或者个人会把一些经常会要用到的资源、比如说,我想把百度的数据用于招聘,那么百度的数据集合就可以用来做网站的招聘内容的爬取了。

我在做一个小的课题,就是爬取校园生活资讯,包括学校各个系团的学生卡信息,然后合成生成各个大学信息栏目的小卡片,为了加强对学校资讯的可视化,设计了这么一个爬虫系统。一般如果项目没有那么复杂,就是爬取学校图书馆里的书籍、课程、讲座、实验数据,同时把相关的信息进行整理,加工。平时遇到需要利用的学校相关的信息,比如就读期间、学位证等信息,也可以以page提交给学校相关的组织或者网站来做相关的数据整理工作。

但是因为是数据量少而且都是固定的资源,所以会做一些简单的数据清洗,去掉或者选取不必要的信息。比如说,我是想要查询下图所示列表里的列表的阅读量,在这个列表里,最上面的那一行是我一本本科参加的学生活动(本科),下面是我在学校成绩排名(研究生),然后每一行还有每个学校的校名(是英文的),每个学校都下面是每个校区的名称,比如上海地区是aa校区(沪市)。

这样,可以解决之前提到的第一点。有一些学校的图书馆在招聘时,在招聘信息里把大学的全称做成描述性词语,这样可以有效的减少用户输入的内容。可以简单做一个查询就可以完成工作,比如说:我想要查询学校在校生的阅读量,我就这样写:http{sender='学校'&postsid='本校本专业的在校生的阅读量'}实现简单可定制的定时提交订单,存储pages或者字段列表等。

系统运行了一年,效果非常好,没有发现出问题。对于是否采用爬虫系统,看过知乎上其他大神的回答,如果数据量不大的话,可以采用!谢谢!。 查看全部

文章采集系统:淘金云采集器,可以根据你所需要的特征去进行抓取

文章采集系统:淘金云采集器,可以根据你所需要的特征去进行抓取。如果你需要爬取app推广位,现在淘金云就有这方面的抓取服务了。

爬虫是什么,百度百科上的解释是:爬虫(trafficprocessor,也称动态网页生成器)是一种无须浏览器即可从互联网上获取海量数据的程序或者系统。网络爬虫,一般是一些有着海量数据的公司或个人,用于网络爬取网页数据的程序或者工具。我的理解是,有一些公司或者个人会把一些经常会要用到的资源、比如说,我想把百度的数据用于招聘,那么百度的数据集合就可以用来做网站的招聘内容的爬取了。

我在做一个小的课题,就是爬取校园生活资讯,包括学校各个系团的学生卡信息,然后合成生成各个大学信息栏目的小卡片,为了加强对学校资讯的可视化,设计了这么一个爬虫系统。一般如果项目没有那么复杂,就是爬取学校图书馆里的书籍、课程、讲座、实验数据,同时把相关的信息进行整理,加工。平时遇到需要利用的学校相关的信息,比如就读期间、学位证等信息,也可以以page提交给学校相关的组织或者网站来做相关的数据整理工作。

但是因为是数据量少而且都是固定的资源,所以会做一些简单的数据清洗,去掉或者选取不必要的信息。比如说,我是想要查询下图所示列表里的列表的阅读量,在这个列表里,最上面的那一行是我一本本科参加的学生活动(本科),下面是我在学校成绩排名(研究生),然后每一行还有每个学校的校名(是英文的),每个学校都下面是每个校区的名称,比如上海地区是aa校区(沪市)。

这样,可以解决之前提到的第一点。有一些学校的图书馆在招聘时,在招聘信息里把大学的全称做成描述性词语,这样可以有效的减少用户输入的内容。可以简单做一个查询就可以完成工作,比如说:我想要查询学校在校生的阅读量,我就这样写:http{sender='学校'&postsid='本校本专业的在校生的阅读量'}实现简单可定制的定时提交订单,存储pages或者字段列表等。

系统运行了一年,效果非常好,没有发现出问题。对于是否采用爬虫系统,看过知乎上其他大神的回答,如果数据量不大的话,可以采用!谢谢!。

巧用爬虫框架爬取几百页源代码都没问题

采集交流 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-06-30 20:03

文章采集系统分享到微信公众号:flowerpu.用后台接口采集,经过测试,是可以直接从指定网站获取网页数据的,最直接的方法是把网页数据,做一个下载工具,如excel导入数据库。其他方法也是经过测试,有时效性,比如获取一批复制模板,这个后台同意可用,但不一定能下载全部数据。所以推荐的方法是借助爬虫框架,如scrapy实现分页采集网页。scrapy爬虫框架主要分为两个部分:分页和分页采集。

一、分页数据怎么采集分页,是你想看某个页面的哪个数据,必须从页面的源代码中提取出来。这一步的工作,是不断浏览页面,获取某个链接下的某个数据,然后,从数据库导出。这个过程非常的费时,特别是爬取test/cookiedata/cookiedata.py里面的数据时,连续获取几十页都要手动操作。有了scrapy分页数据,可以方便非常多。

一个网站如果有多个test/cookiedata/cookiedata.py里面,可以方便的按页面查看分页的结果,比如一页有100个数据,分别标记为#1,#2,#3,#4,#5,#6等等,如下图:有了分页数据,接下来就是分页数据怎么采集了。

二、分页采集分页数据采集,是对页面进行采集,从指定页面获取一些数据,主要分为两个步骤:第一,打开分页链接。第二,从页面中查找,需要的数据。我们分页数据采集,是通过scrapy爬虫框架实现的。

三、scrapy爬虫框架用于分页的分页采集框架,如scrapyfilm一个爬虫框架,爬取几百页源代码都没问题,这里主要分享如何使用此框架爬取整个页面的分页数据。scrapyfilm采集页面源代码,如下图:简单讲讲,爬取整个页面分页数据,需要参数的具体用法。在python中获取一个网页,要使用requests库。

爬取页面里面,有两个请求,一个是selector请求,一个是headers请求。我们写爬虫,都会写一个scrapyfilm爬虫,这个爬虫,主要是模拟爬取一个网页代码,爬取出来的页面,其实也就是一个请求。如下图:我们假设要爬取的页面是:,打开分页页面,如下图:可以看到,爬取出来是一个链接,链接上面包含一些需要爬取的页面:,接下来,我们就需要把这个链接,和整个页面都采集下来,爬取出来后,把页面文件里面的分页数据采集出来。

整个爬取过程,

1、获取页面的page标记

2、获取分页数据

3、跳转到指定的页面,获取对应的页面分页数据。scrapyfilm爬虫,并不像我们平时使用excel中导入数据进行爬取,它采用的请求页面,并返回对应页面的内容,然后返回结果,还可以重复提取页面分页数据。

如下图:主要分为三步:

1、获取这个页面的index这个 查看全部

巧用爬虫框架爬取几百页源代码都没问题

文章采集系统分享到微信公众号:flowerpu.用后台接口采集,经过测试,是可以直接从指定网站获取网页数据的,最直接的方法是把网页数据,做一个下载工具,如excel导入数据库。其他方法也是经过测试,有时效性,比如获取一批复制模板,这个后台同意可用,但不一定能下载全部数据。所以推荐的方法是借助爬虫框架,如scrapy实现分页采集网页。scrapy爬虫框架主要分为两个部分:分页和分页采集。

一、分页数据怎么采集分页,是你想看某个页面的哪个数据,必须从页面的源代码中提取出来。这一步的工作,是不断浏览页面,获取某个链接下的某个数据,然后,从数据库导出。这个过程非常的费时,特别是爬取test/cookiedata/cookiedata.py里面的数据时,连续获取几十页都要手动操作。有了scrapy分页数据,可以方便非常多。

一个网站如果有多个test/cookiedata/cookiedata.py里面,可以方便的按页面查看分页的结果,比如一页有100个数据,分别标记为#1,#2,#3,#4,#5,#6等等,如下图:有了分页数据,接下来就是分页数据怎么采集了。

二、分页采集分页数据采集,是对页面进行采集,从指定页面获取一些数据,主要分为两个步骤:第一,打开分页链接。第二,从页面中查找,需要的数据。我们分页数据采集,是通过scrapy爬虫框架实现的。

三、scrapy爬虫框架用于分页的分页采集框架,如scrapyfilm一个爬虫框架,爬取几百页源代码都没问题,这里主要分享如何使用此框架爬取整个页面的分页数据。scrapyfilm采集页面源代码,如下图:简单讲讲,爬取整个页面分页数据,需要参数的具体用法。在python中获取一个网页,要使用requests库。

爬取页面里面,有两个请求,一个是selector请求,一个是headers请求。我们写爬虫,都会写一个scrapyfilm爬虫,这个爬虫,主要是模拟爬取一个网页代码,爬取出来的页面,其实也就是一个请求。如下图:我们假设要爬取的页面是:,打开分页页面,如下图:可以看到,爬取出来是一个链接,链接上面包含一些需要爬取的页面:,接下来,我们就需要把这个链接,和整个页面都采集下来,爬取出来后,把页面文件里面的分页数据采集出来。

整个爬取过程,

1、获取页面的page标记

2、获取分页数据

3、跳转到指定的页面,获取对应的页面分页数据。scrapyfilm爬虫,并不像我们平时使用excel中导入数据进行爬取,它采用的请求页面,并返回对应页面的内容,然后返回结果,还可以重复提取页面分页数据。

如下图:主要分为三步:

1、获取这个页面的index这个

开放获取期刊资源及其采集方法和系统实现做了以下研究

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-06-27 19:23

随着开放获取运动的发展,越来越多的期刊加入了开放获取的行列。开放获取期刊资源经过同行评审,保证学术质量,分布广泛,具有重要的学术价值。研究开放获取期刊资源采集是有效利用资源的基础。对于OAI-PMH协议下的开放获取期刊,OAI-PMH接口通常用于采集期刊资源。对于非OAI-PMH开放获取期刊,期刊网页中的元数据信息一般为采集。但是,开放获取期刊是由期刊机构组织和展示的。不同的期刊采用不同的资源展示形式。同一个期刊在不同时期可能有不同形式的资源展示,可谓“千本”。资源呈现形式大多改为非OAI-PMH协议开放获取期刊资源采集,带来一定难度。为了解决这个问题,本文对开放获取期刊资源及其采集方法和系统实现做了如下研究。首先,本文对国内外大量开放获取期刊网站进行了采集调查,从网络资源描述的角度总结出开放获取期刊资源具有细粒度描述的特点,复杂描述和可变描述载体结构。按资源组织形式分为单一资源和组合资源。在对当前主流资源采集方法进行对比分析的基础上,结合开放获取期刊资源的特点,提出一种适用于开放获取期刊资源采集的方法。然后,在详细分析了开放获取期刊资源采集系统的目标和需求之后,本文对比了当前网页采集tool及其在开放获取期刊资源采集上的应用,分析了其发展情况开放获取期刊资源采集系统的必要性。

接下来提出的开放获取期刊资源的采集方法是系统的整体设计。系统主要分为三个模块:用户交互模块、数据采集和网页结构检查模块、数据存储模块。系统实现的主要功能包括可视化信息采集、采集规则自动形成、多线程自动采集、网页结构检查、数据质量检查等功能。然后详细介绍了系统的三大模块和主要功能点的具体实现,并通过编码实现了系统的具体功能。同时,从功能和性能的角度对系统进行了测试。在功能测试中,系统可以对单个资源和组合资源进行采集,可以准确识别期刊网站网页结构的变化,并将结构变化后的页面反馈给用户重新选择和采集,系统具备资源采集的基本功能。在性能测试中,通过对比系统与优采云采集器在同一期刊资源采集上的效果,结果表明该系统在召回率和准确率上均优于优采云采集器。此外,系统对12个非OAI-PMH开放获取期刊网站进行了采集,共采集到达49,660篇论文。总耗时为31659秒,平均每千人花费文章采集时间为10.62分钟。系统采集的论文数加上用户标记的脏页数之和,与爬虫脚本采集的论文链接数完全相同。表明该系统能够满足采集对开放获取期刊资源的需求,同时验证了本文提出的开放获取期刊资源采集方法的有效性。最后总结了论文的主要研究内容及不足之处。它也期待下一步。开放获取期刊资源采集是使用开放获取期刊资源的第一步,也是最基本的一步。充分利用开放获取期刊资源,需要进行数据清洗、数据仓库建设、数据分析平台、数据可视化展示等一系列工作。 查看全部

开放获取期刊资源及其采集方法和系统实现做了以下研究

随着开放获取运动的发展,越来越多的期刊加入了开放获取的行列。开放获取期刊资源经过同行评审,保证学术质量,分布广泛,具有重要的学术价值。研究开放获取期刊资源采集是有效利用资源的基础。对于OAI-PMH协议下的开放获取期刊,OAI-PMH接口通常用于采集期刊资源。对于非OAI-PMH开放获取期刊,期刊网页中的元数据信息一般为采集。但是,开放获取期刊是由期刊机构组织和展示的。不同的期刊采用不同的资源展示形式。同一个期刊在不同时期可能有不同形式的资源展示,可谓“千本”。资源呈现形式大多改为非OAI-PMH协议开放获取期刊资源采集,带来一定难度。为了解决这个问题,本文对开放获取期刊资源及其采集方法和系统实现做了如下研究。首先,本文对国内外大量开放获取期刊网站进行了采集调查,从网络资源描述的角度总结出开放获取期刊资源具有细粒度描述的特点,复杂描述和可变描述载体结构。按资源组织形式分为单一资源和组合资源。在对当前主流资源采集方法进行对比分析的基础上,结合开放获取期刊资源的特点,提出一种适用于开放获取期刊资源采集的方法。然后,在详细分析了开放获取期刊资源采集系统的目标和需求之后,本文对比了当前网页采集tool及其在开放获取期刊资源采集上的应用,分析了其发展情况开放获取期刊资源采集系统的必要性。

接下来提出的开放获取期刊资源的采集方法是系统的整体设计。系统主要分为三个模块:用户交互模块、数据采集和网页结构检查模块、数据存储模块。系统实现的主要功能包括可视化信息采集、采集规则自动形成、多线程自动采集、网页结构检查、数据质量检查等功能。然后详细介绍了系统的三大模块和主要功能点的具体实现,并通过编码实现了系统的具体功能。同时,从功能和性能的角度对系统进行了测试。在功能测试中,系统可以对单个资源和组合资源进行采集,可以准确识别期刊网站网页结构的变化,并将结构变化后的页面反馈给用户重新选择和采集,系统具备资源采集的基本功能。在性能测试中,通过对比系统与优采云采集器在同一期刊资源采集上的效果,结果表明该系统在召回率和准确率上均优于优采云采集器。此外,系统对12个非OAI-PMH开放获取期刊网站进行了采集,共采集到达49,660篇论文。总耗时为31659秒,平均每千人花费文章采集时间为10.62分钟。系统采集的论文数加上用户标记的脏页数之和,与爬虫脚本采集的论文链接数完全相同。表明该系统能够满足采集对开放获取期刊资源的需求,同时验证了本文提出的开放获取期刊资源采集方法的有效性。最后总结了论文的主要研究内容及不足之处。它也期待下一步。开放获取期刊资源采集是使用开放获取期刊资源的第一步,也是最基本的一步。充分利用开放获取期刊资源,需要进行数据清洗、数据仓库建设、数据分析平台、数据可视化展示等一系列工作。

文章采集系统基本就是能采集网络爬虫所采集的数据

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-06-21 00:03

文章采集系统基本就是能采集网络爬虫所采集的数据,并通过正则等方法过滤一遍再存储至你自己的数据库。这个看你自己有什么特长,发展方向,如果是希望能做一个类似微博爬虫一样的产品,采集结果自动分析。也可以采集相关产品的数据,如,打车软件的数据就可以采集到坐标信息,其他软件可以复制关键字去爬数据,或者买几家产品数据去爬到产品坐标信息,再组织集中在某个软件统一收集。

一般代理服务器是没有的,真正做的好的都是几台节点机器组成集群,自己搭建比较费时费力。sina微博应该也有集群比较成熟的方案,不过不清楚名字。

简单回答下个人理解,之前也有过类似想法,后来搞的太复杂,现在也很少做。由于微博实名制和采集需要权限等,现在爬虫程序就是借助采集工具+脚本的方式获取数据。用户在微博上做出的每一个行为记录会存到本地的数据库中。微博上可以登录多个账号就可以同时抓取网页,且操作非常方便,理论上来说足够大就可以无限制地抓取数据。

1.微博采集工具太多,你可以用比较受欢迎的爬虫软件的,amazonalexa和java都有这种脚本。看这里google’swebscraper2.amazonpil,不用下载,网的店铺信息也是我们帮他抓取的。

可以是很久以前写的爬虫工具,不过因为某种原因我这边关掉了。微博一般都是需要能记录关键字(当然可以是转发、评论、赞这些信息,并且需要转发权限),之后进行话题抓取。 查看全部

文章采集系统基本就是能采集网络爬虫所采集的数据

文章采集系统基本就是能采集网络爬虫所采集的数据,并通过正则等方法过滤一遍再存储至你自己的数据库。这个看你自己有什么特长,发展方向,如果是希望能做一个类似微博爬虫一样的产品,采集结果自动分析。也可以采集相关产品的数据,如,打车软件的数据就可以采集到坐标信息,其他软件可以复制关键字去爬数据,或者买几家产品数据去爬到产品坐标信息,再组织集中在某个软件统一收集。

一般代理服务器是没有的,真正做的好的都是几台节点机器组成集群,自己搭建比较费时费力。sina微博应该也有集群比较成熟的方案,不过不清楚名字。

简单回答下个人理解,之前也有过类似想法,后来搞的太复杂,现在也很少做。由于微博实名制和采集需要权限等,现在爬虫程序就是借助采集工具+脚本的方式获取数据。用户在微博上做出的每一个行为记录会存到本地的数据库中。微博上可以登录多个账号就可以同时抓取网页,且操作非常方便,理论上来说足够大就可以无限制地抓取数据。

1.微博采集工具太多,你可以用比较受欢迎的爬虫软件的,amazonalexa和java都有这种脚本。看这里google’swebscraper2.amazonpil,不用下载,网的店铺信息也是我们帮他抓取的。

可以是很久以前写的爬虫工具,不过因为某种原因我这边关掉了。微博一般都是需要能记录关键字(当然可以是转发、评论、赞这些信息,并且需要转发权限),之后进行话题抓取。

文章采集系统产品一般需要具备的三个基本功能!

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-06-20 19:47

文章采集系统产品一般需要具备文章采集系统的三个基本功能:1采集多平台文章,发布并维护用户历史兴趣记录;2用户喜欢按时间采集,用户退出后没有记录可用;3隐私保护,作者可根据需要或不同情况,选择是否与网站以及网站的其他用户开放商业性的版权采集。如何制作采集系统?1.信息源:市面上目前的采集系统一般分为两种,一种是供开发者免费试用,一种是要收费。

如果对方开发者愿意免费试用我们可以采用,如果收费或多次购买的话,我们可以找规模相对大一些的采集厂商。2.采集软件:采集软件用于与采集系统集成的采集工具,采集软件厂商主要分为两种,一种是有开发者的,一种是没有开发者的。后者还是有选择性的,因为可能某些网站的数据存在泄漏风险,或者采集策略比较多,也是需要选择有开发者的。

1)数据集成a)数据集成是指相关系统需要调用采集软件,按软件提供的数据源进行采集;b)相关系统需要调用采集软件,不是硬件调用,不是程序自己接入,而是采集工具的内置接口;c)采集程序需要设置与采集软件的兼容性,不同的采集软件对一般的采集程序都是兼容的。相对不稳定的比如wps2012这样的,注意:采集策略可能会显示不正确,但是不影响采集软件正常的工作,只是需要一些时间优化;相对稳定的比如teazy(q群)这样的,注意:采集策略一般也是要定制的,如果其他软件帮你走对应的程序,可能不用帮你重新做程序。

2)采集策略:集成和采集策略一般是不需要集成的,因为相关的采集软件对于同类的集成基本上都是一样的,比如全文检索、中文分词、关键词库建立等等,除非有一些不明确的条件就是不给你做集成的。采集策略其实包含了数据格式策略和软件相关指令,比如标点码、音频编码、转码、md5校验等等,软件的指令也不是全部涵盖进去的,我们这里主要说采集策略。

3)维护与日志统计:采集软件上的各种日志都要人工查看的,不同的策略可能要看不同类型的日志,这个分在每个工厂上每天的工作量还是很大的。

4)数据分析:采集系统会有一些分析,比如词频统计、全文分析、文档分析、内容聚合、漏斗、人群分析、渠道分析等等,这个根据采集场景不同会需要不同的分析功能。

5)搜索引擎推广,

6)管理员账号、授权、权限、数据导出、大全页采集、全文检索等;

7)数据存储:一般都是excel+合作采集的云工厂的文件,你可以简单的理解为excel+云文件就可以。2.数据实时同步:数据实时同步包括云协议的实时同步, 查看全部

文章采集系统产品一般需要具备的三个基本功能!

文章采集系统产品一般需要具备文章采集系统的三个基本功能:1采集多平台文章,发布并维护用户历史兴趣记录;2用户喜欢按时间采集,用户退出后没有记录可用;3隐私保护,作者可根据需要或不同情况,选择是否与网站以及网站的其他用户开放商业性的版权采集。如何制作采集系统?1.信息源:市面上目前的采集系统一般分为两种,一种是供开发者免费试用,一种是要收费。

如果对方开发者愿意免费试用我们可以采用,如果收费或多次购买的话,我们可以找规模相对大一些的采集厂商。2.采集软件:采集软件用于与采集系统集成的采集工具,采集软件厂商主要分为两种,一种是有开发者的,一种是没有开发者的。后者还是有选择性的,因为可能某些网站的数据存在泄漏风险,或者采集策略比较多,也是需要选择有开发者的。

1)数据集成a)数据集成是指相关系统需要调用采集软件,按软件提供的数据源进行采集;b)相关系统需要调用采集软件,不是硬件调用,不是程序自己接入,而是采集工具的内置接口;c)采集程序需要设置与采集软件的兼容性,不同的采集软件对一般的采集程序都是兼容的。相对不稳定的比如wps2012这样的,注意:采集策略可能会显示不正确,但是不影响采集软件正常的工作,只是需要一些时间优化;相对稳定的比如teazy(q群)这样的,注意:采集策略一般也是要定制的,如果其他软件帮你走对应的程序,可能不用帮你重新做程序。

2)采集策略:集成和采集策略一般是不需要集成的,因为相关的采集软件对于同类的集成基本上都是一样的,比如全文检索、中文分词、关键词库建立等等,除非有一些不明确的条件就是不给你做集成的。采集策略其实包含了数据格式策略和软件相关指令,比如标点码、音频编码、转码、md5校验等等,软件的指令也不是全部涵盖进去的,我们这里主要说采集策略。

3)维护与日志统计:采集软件上的各种日志都要人工查看的,不同的策略可能要看不同类型的日志,这个分在每个工厂上每天的工作量还是很大的。

4)数据分析:采集系统会有一些分析,比如词频统计、全文分析、文档分析、内容聚合、漏斗、人群分析、渠道分析等等,这个根据采集场景不同会需要不同的分析功能。

5)搜索引擎推广,

6)管理员账号、授权、权限、数据导出、大全页采集、全文检索等;

7)数据存储:一般都是excel+合作采集的云工厂的文件,你可以简单的理解为excel+云文件就可以。2.数据实时同步:数据实时同步包括云协议的实时同步,

猪八戒网站的设计师帮你画也可以很贵

采集交流 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-06-16 22:01

文章采集系统这方面,可以尝试用猪八戒网这样的平台进行合作,对接企业在猪八戒上发布需求。猪八戒上有时候也会有一些免费的找素材的机会,直接和厂家联系就行。提供一个站点,可以联系猪八戒网站的设计师了解一下这个行业(猪八戒上有很多设计师,或许可以找到合适的合作机会)-new-source/4478387。

我做过h5方面的市场调查,你可以看看我之前写的一篇文章,相对市场调查比较全面的。

如果是给微信公众号画画,我推荐你两个公众号,微言客,夏蒙share这两个都是专门做微信公众号设计的。里面有很多大触,

估计你要的是免费素材吧,

猪八戒这类网站有很多啊,发布需求就可以了,

首先你得对做手机h5感兴趣,不然完全没法做出来,

如果你只是用软件模仿,个人觉得找不到什么东西。首先你得想办法在别人的软件上实现出来,比如做一个微信公众号,然后去投资一个做手机h5的公司,然后洽谈他们合作就可以做出相应的h5,然后你再画也是有很多种说法,可以用sketch,可以用invision等等~~然后怎么画,就看你们公司了,要不找好的设计师帮你画也可以,就是比较贵~~。 查看全部

猪八戒网站的设计师帮你画也可以很贵

文章采集系统这方面,可以尝试用猪八戒网这样的平台进行合作,对接企业在猪八戒上发布需求。猪八戒上有时候也会有一些免费的找素材的机会,直接和厂家联系就行。提供一个站点,可以联系猪八戒网站的设计师了解一下这个行业(猪八戒上有很多设计师,或许可以找到合适的合作机会)-new-source/4478387。

我做过h5方面的市场调查,你可以看看我之前写的一篇文章,相对市场调查比较全面的。

如果是给微信公众号画画,我推荐你两个公众号,微言客,夏蒙share这两个都是专门做微信公众号设计的。里面有很多大触,

估计你要的是免费素材吧,

猪八戒这类网站有很多啊,发布需求就可以了,

首先你得对做手机h5感兴趣,不然完全没法做出来,

如果你只是用软件模仿,个人觉得找不到什么东西。首先你得想办法在别人的软件上实现出来,比如做一个微信公众号,然后去投资一个做手机h5的公司,然后洽谈他们合作就可以做出相应的h5,然后你再画也是有很多种说法,可以用sketch,可以用invision等等~~然后怎么画,就看你们公司了,要不找好的设计师帮你画也可以,就是比较贵~~。

开源软件选型:为什么需要日志收集(一)(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2021-06-05 18:03

开源软件选型:为什么需要日志收集(一)(图)

1.为什么需要采集日志

当我们网站的规模很大到一定程度时,我们的服务就分散在不同的主机上。当网站异常时,我们通常会使用这些服务的日志来排查系统故障。因为很多主机的日志分散在不同的主机上,使得我们的日志分析效率太低。日志采集系统可以将所有不同主机的日志聚合到一个系统中,方便我们查看和分析。

2.开源软件精选

市场上有各种日志采集系统。日志采集和分析通过多个Karry软件集成完成,包括si部分:

采集 -> 分析 -> 存储 -> 背景

集合包括 Apache 的 Flume、Facebook 的 Scribe、Elasic 的 Filebeat、Logstash

Logstash 是用来做分析的,但是我还没研究过,所以暂时不需要

Elasticsearch、Hdfs(Hadoop、Storm)等用于存储。

Kibana 和 grafana 是后端

hdfs 主要用于日志的大数据分析。它更重,不适合我们。 Eliastic 有完整的日志解决方案。

Elk(Elasticsearch + Logstash + kibana)通常被称为。 Logstash 比较大。一般用于日志分析和格式化(二次处理)。日志采集使用Firebeat和Flume也不错,但是需要java环境。 Friebeat是用go编写的,可以直接运行在环境的每一个依赖上,而且非常轻量级,3M左右,非常有利于部署和实现。

Eliasticsearch搜索的效率不用多说,它经常用于存储时间序列数据,这个本身我也有一定的了解

Kibana 用于日志查看和分析。它可以与 Elasticsearch 结合使用。可以通过es、Dashboard数据监控面板中搜索到的数据直观展示

所以最后选择通过Filebeat + Elasitcsearch + Kibana(Logstash可选)来实现我们的日志采集系统

目前 Kibana 的稳定版本是4.4,但它依赖于 Elasticsearch 2 或更高版本,

之前用过Elasticsearch 1.7,所以选择了Elasticsearch 1.7 + Kibana 4.1

3.安装部署

在centos 6.x 环境中

3.1 在日志所在的服务器上安装Filebeat

sudo rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

添加以下内容

[beats]

name=Elastic Beats Repository

baseurl=https://packages.elastic.co/beats/yum/el/$basearch

enabled=1

gpgkey=https://packages.elastic.co/GPG-KEY-elasticsearch

gpgcheck=1

另存为 /etc/yum.repos.d/beat.repo 文件

开始安装

yum -y install filebeat

chkconfig --add filebeat

启动命令

/etc/init.d/filebeat start

3.2 在日志服务器上安装 Elasticsearch

mkdir -p ~/download && cd ~/download

wget -c https://download.elastic.co/el ... 2.zip

unzip elasticsearch-1.7.2.zip

mv elasticsearch-1.7.2 /usr/local/elasticsearch

启动命令

cd /usr/local/elasticsearch/bin

./elasticsearch -d

3.3 在日志服务器上安装 Kibana

rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

cat > /etc/yum.repos.d/kibana.repo

[kibana-4.1]

name=Kibana repository for 4.1.x packages

baseurl=http://packages.elastic.co/kibana/4.1/centos

gpgcheck=1

gpgkey=http://packages.elastic.co/GPG-KEY-elasticsearch

enabled=1

yum install kibana

chkconfig --add kibana

启动命令

/etc/init.d/kibana start

4.如何使用

如果我们有一台运行nginx+php-fpm的web服务器,我们需要采集php-fpm的错误日志和慢日志

4.1配置文件节拍

filebeat:

prospectors:

-

document_type: "php-fpm"

paths:

- /var/log/php/php-fpm.log

-

document_type: "php-fpm.slow"

paths:

- /var/log/php/slow.log

multiline:

pattern: '^[[:space:]]'

negate: true

match: after

output:

elasticsearch:

hosts: ["192.168.1.88:9200"]

shipper:

tags: ["web"]

以上配置的意思是从两个位置采集日志:/var/log/server/php/php-fpm.log,/var/log/server/php/cloud.slow.log,

由于slow log中有多行作为一条记录,filebeat使用三种配置将多行转为一行,pattern、negate、match。上面配置的意思是,如果一行不以空格开头,就会拼接到上一行的后面,

pattern 遵循 golang 的正则语法

输出命令指定将日志输出到elasticsearch,并添加服务的ip和端口,可以添加多个单元,也可以支持负余额

可以在shipper中指定一些tag,方便后面kibana过滤数据

好的,重启filebeat,/etc/init.d/filebeat restart

4.2 配置 Elasticsearch

确保 Elasticsearch 已启动

4.3 配置kibana

安装filebeat等示例仪表板

mkdir -p ~/download && cd ~/download

curl -L -O http://download.elastic.co/bea ... 1.zip

unzip beats-dashboards-1.3.1.zip

cd beats-dashboards-1.3.1/

./load.sh

默认情况下,脚本假设 Elasticsearch 在 127.0.0.1:9200 上运行。使用 -url 选项指定另一个位置。例如:./load.sh -url :9200。

Kibana 需要配置elasticsearch的地址和端口。现在这两个服务都在同一台机器上。默认配置为localhost:9200,无需更改

4.4 打开kibana

kibana 启动后,默认端口为 5601,从浏览器打开:5601

kibana 会加载一个 5m 的 js,请耐心等待

打开后的界面是这样的

改为filebeat-*

点击创建,然后点击发现。如果进入后日志中有数据,我们应该可以看到类似下图的界面

区域说明

点击type查看我们在filebeat中指定的日志名称

还有更多功能自己去发现。

4.5 参考资料

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html 查看全部

开源软件选型:为什么需要日志收集(一)(图)

1.为什么需要采集日志

当我们网站的规模很大到一定程度时,我们的服务就分散在不同的主机上。当网站异常时,我们通常会使用这些服务的日志来排查系统故障。因为很多主机的日志分散在不同的主机上,使得我们的日志分析效率太低。日志采集系统可以将所有不同主机的日志聚合到一个系统中,方便我们查看和分析。

2.开源软件精选

市场上有各种日志采集系统。日志采集和分析通过多个Karry软件集成完成,包括si部分:

采集 -> 分析 -> 存储 -> 背景

集合包括 Apache 的 Flume、Facebook 的 Scribe、Elasic 的 Filebeat、Logstash

Logstash 是用来做分析的,但是我还没研究过,所以暂时不需要

Elasticsearch、Hdfs(Hadoop、Storm)等用于存储。

Kibana 和 grafana 是后端

hdfs 主要用于日志的大数据分析。它更重,不适合我们。 Eliastic 有完整的日志解决方案。

Elk(Elasticsearch + Logstash + kibana)通常被称为。 Logstash 比较大。一般用于日志分析和格式化(二次处理)。日志采集使用Firebeat和Flume也不错,但是需要java环境。 Friebeat是用go编写的,可以直接运行在环境的每一个依赖上,而且非常轻量级,3M左右,非常有利于部署和实现。

Eliasticsearch搜索的效率不用多说,它经常用于存储时间序列数据,这个本身我也有一定的了解

Kibana 用于日志查看和分析。它可以与 Elasticsearch 结合使用。可以通过es、Dashboard数据监控面板中搜索到的数据直观展示

所以最后选择通过Filebeat + Elasitcsearch + Kibana(Logstash可选)来实现我们的日志采集系统

目前 Kibana 的稳定版本是4.4,但它依赖于 Elasticsearch 2 或更高版本,

之前用过Elasticsearch 1.7,所以选择了Elasticsearch 1.7 + Kibana 4.1

3.安装部署

在centos 6.x 环境中

3.1 在日志所在的服务器上安装Filebeat

sudo rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

添加以下内容

[beats]

name=Elastic Beats Repository

baseurl=https://packages.elastic.co/beats/yum/el/$basearch

enabled=1

gpgkey=https://packages.elastic.co/GPG-KEY-elasticsearch

gpgcheck=1

另存为 /etc/yum.repos.d/beat.repo 文件

开始安装

yum -y install filebeat

chkconfig --add filebeat

启动命令

/etc/init.d/filebeat start

3.2 在日志服务器上安装 Elasticsearch

mkdir -p ~/download && cd ~/download

wget -c https://download.elastic.co/el ... 2.zip

unzip elasticsearch-1.7.2.zip

mv elasticsearch-1.7.2 /usr/local/elasticsearch

启动命令

cd /usr/local/elasticsearch/bin

./elasticsearch -d

3.3 在日志服务器上安装 Kibana

rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

cat > /etc/yum.repos.d/kibana.repo

[kibana-4.1]

name=Kibana repository for 4.1.x packages

baseurl=http://packages.elastic.co/kibana/4.1/centos

gpgcheck=1

gpgkey=http://packages.elastic.co/GPG-KEY-elasticsearch

enabled=1

yum install kibana

chkconfig --add kibana

启动命令

/etc/init.d/kibana start

4.如何使用

如果我们有一台运行nginx+php-fpm的web服务器,我们需要采集php-fpm的错误日志和慢日志

4.1配置文件节拍

filebeat:

prospectors:

-

document_type: "php-fpm"

paths:

- /var/log/php/php-fpm.log

-

document_type: "php-fpm.slow"

paths:

- /var/log/php/slow.log

multiline:

pattern: '^[[:space:]]'

negate: true

match: after

output:

elasticsearch:

hosts: ["192.168.1.88:9200"]

shipper:

tags: ["web"]

以上配置的意思是从两个位置采集日志:/var/log/server/php/php-fpm.log,/var/log/server/php/cloud.slow.log,

由于slow log中有多行作为一条记录,filebeat使用三种配置将多行转为一行,pattern、negate、match。上面配置的意思是,如果一行不以空格开头,就会拼接到上一行的后面,

pattern 遵循 golang 的正则语法

输出命令指定将日志输出到elasticsearch,并添加服务的ip和端口,可以添加多个单元,也可以支持负余额

可以在shipper中指定一些tag,方便后面kibana过滤数据

好的,重启filebeat,/etc/init.d/filebeat restart

4.2 配置 Elasticsearch

确保 Elasticsearch 已启动

4.3 配置kibana

安装filebeat等示例仪表板

mkdir -p ~/download && cd ~/download

curl -L -O http://download.elastic.co/bea ... 1.zip

unzip beats-dashboards-1.3.1.zip

cd beats-dashboards-1.3.1/

./load.sh

默认情况下,脚本假设 Elasticsearch 在 127.0.0.1:9200 上运行。使用 -url 选项指定另一个位置。例如:./load.sh -url :9200。

Kibana 需要配置elasticsearch的地址和端口。现在这两个服务都在同一台机器上。默认配置为localhost:9200,无需更改

4.4 打开kibana

kibana 启动后,默认端口为 5601,从浏览器打开:5601

kibana 会加载一个 5m 的 js,请耐心等待

打开后的界面是这样的

改为filebeat-*

点击创建,然后点击发现。如果进入后日志中有数据,我们应该可以看到类似下图的界面

区域说明

点击type查看我们在filebeat中指定的日志名称

还有更多功能自己去发现。

4.5 参考资料

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html

https://www.elastic.co/guide/e ... .html

文章采集系统:这种采集的工具还是蛮多的?

采集交流 • 优采云 发表了文章 • 0 个评论 • 161 次浏览 • 2021-05-29 00:03

文章采集系统:这种采集的工具还是蛮多的比如:whois1010、脉脉采集、网友微博采集、知乎内容采集...样式采集工具:网页上的图片、网页上的文字、网页上的pdf、网页上的视频等内容进行采集下载,这种采集方式多为网页上的静态资源,比如:知乎上的头像等内容网络爬虫工具:随着互联网发展,现在移动互联网app的种类越来越多,为了避免爬虫代理ip不合规矩,并且抓取页面不准确,所以就出现了爬虫这个东西,就是程序抓取页面,解析表单之类,并且生成爬虫就是抓取内容然后实时上传推送后台给用户啦。

这个过程好在抓取成本低,但是抓取效率跟过滤难度都大大提高,并且会爬取限制多,搜索引擎公开抓取不合规和大尺寸问题都会成为潜在风险。思维采集工具:读取网页的关键词、主题关键词进行组合起来,找出话题排行榜,发现热点,把关键词相关的网页逐个爬取下来,但是仅限关键词相关的这些相关页面,并且并不能处理太复杂的,比如页面文章对网站有新浪、百度、凤凰等这些域名进行爬取,你怎么进行爬取?流行网站爬取工具:有些流行的网站可能已经停止运营,现在的爬虫抓取并没有这些网站的数据,怎么办?都知道只能自己制作抓取,但是制作流行网站的机器人太耗时了,一个单点式的程序抓取很简单,却有很大的弊端,编写机器人每天工作太多,产生大量bug,你想自己制作爬虫却又不愿意花心思思考。

解决这些问题的工具有这个版本的网络爬虫工具,请求数据采集工具:爬虫里面涉及的http请求大多数的网站都会涉及到,但是有些网站还是不支持qq或者邮箱等,这个时候你就用到这个爬虫采集工具,把这些网站中涉及到的相关http请求抓取下来,分析这些请求代码。爬虫数据采集工具:按照爬虫来分,获取的数据可以有两种:原始页面和抓取页面。

如果是抓取页面,一般就是xml格式的,下面有个xml下载器的工具,如果有精力可以从实际来制作这种工具。对于大多数的网站,这样的工具无法满足要求,因为网站大多数都是静态文件,如果要爬取页面可以用程序去处理。 查看全部

文章采集系统:这种采集的工具还是蛮多的?

文章采集系统:这种采集的工具还是蛮多的比如:whois1010、脉脉采集、网友微博采集、知乎内容采集...样式采集工具:网页上的图片、网页上的文字、网页上的pdf、网页上的视频等内容进行采集下载,这种采集方式多为网页上的静态资源,比如:知乎上的头像等内容网络爬虫工具:随着互联网发展,现在移动互联网app的种类越来越多,为了避免爬虫代理ip不合规矩,并且抓取页面不准确,所以就出现了爬虫这个东西,就是程序抓取页面,解析表单之类,并且生成爬虫就是抓取内容然后实时上传推送后台给用户啦。

这个过程好在抓取成本低,但是抓取效率跟过滤难度都大大提高,并且会爬取限制多,搜索引擎公开抓取不合规和大尺寸问题都会成为潜在风险。思维采集工具:读取网页的关键词、主题关键词进行组合起来,找出话题排行榜,发现热点,把关键词相关的网页逐个爬取下来,但是仅限关键词相关的这些相关页面,并且并不能处理太复杂的,比如页面文章对网站有新浪、百度、凤凰等这些域名进行爬取,你怎么进行爬取?流行网站爬取工具:有些流行的网站可能已经停止运营,现在的爬虫抓取并没有这些网站的数据,怎么办?都知道只能自己制作抓取,但是制作流行网站的机器人太耗时了,一个单点式的程序抓取很简单,却有很大的弊端,编写机器人每天工作太多,产生大量bug,你想自己制作爬虫却又不愿意花心思思考。

解决这些问题的工具有这个版本的网络爬虫工具,请求数据采集工具:爬虫里面涉及的http请求大多数的网站都会涉及到,但是有些网站还是不支持qq或者邮箱等,这个时候你就用到这个爬虫采集工具,把这些网站中涉及到的相关http请求抓取下来,分析这些请求代码。爬虫数据采集工具:按照爬虫来分,获取的数据可以有两种:原始页面和抓取页面。

如果是抓取页面,一般就是xml格式的,下面有个xml下载器的工具,如果有精力可以从实际来制作这种工具。对于大多数的网站,这样的工具无法满足要求,因为网站大多数都是静态文件,如果要爬取页面可以用程序去处理。

文章采集系统crawler--高效的人工智能平台系统架构图

采集交流 • 优采云 发表了文章 • 0 个评论 • 164 次浏览 • 2021-05-28 20:04

文章采集系统crawler---高效的人工智能平台系统架构图之前做人工智能产品咨询过程中经常用到的系统架构图:无论是从支持什么业务到组合成具体业务需求,

一),

二)。图一为专注智能金融领域的专业平台windcenter分析框架。

三)。如果你是一位金融产品设计者,也许你也想知道关于产品设计的一个系统架构图的示例。也许你对自己的人工智能系统有新的设计需求,

四)。如果你想设计更清晰高效的人工智能产品,就请把图一中一些没有解释清楚的部分补充进来,不要急于求成,先从通用性的架构图入手,通过系统架构图逐步完善业务流程,再做人工智能系统。选择新的业务、人工智能模型依赖于已有的架构图的业务路径、人工智能平台的架构。高效人工智能平台的搭建过程是以产品为导向,实践是核心,不断测试才能生成最好的系统架构图。

在合适的时机(如当我在为运营团队成员培训职业生涯规划时)把新技术加入进来,考虑更清晰的ai架构图是最为有效的方法,现在架构图画不画也无所谓了。windcenter3.0已经明确通过各种特性(即使是金融业务也可以适用)把金融产品的ai运营、人工智能产品化落地。那么高效的人工智能平台在实践过程中最重要的特性有哪些呢?可以从三个维度展开分析:用户驱动、业务驱动、生态驱动。

简而言之,用户驱动就是满足用户需求;业务驱动就是满足业务需求;生态驱动就是通过满足整个行业需求和各种第三方服务以及跨越各个行业的通用ai技术实现跨行业的人工智能。在用户驱动的基础上,业务驱动,业务驱动与平台搭建起来后,生态驱动才是系统的生命线,实现生态驱动的问题就是平台或产品的问题。二者结合才能发挥最大的价值。

上图中只是把业务、技术和生态关系明确,可以进一步深入了解其中奥妙,

一、图二用户驱动,

三、图四业务驱动,

三、图五生态驱动,

六、ai产品性能指标图如图

七、图八所示,我们提供了各模块的ai运营、生态驱动、业务驱动的基础数据,但是通过产品架构图以及用户驱动、业务驱动和生态驱动的细节,我们能够更清晰的看到金融产品实践的整个过程和最终产品形态如何。 查看全部

文章采集系统crawler--高效的人工智能平台系统架构图

文章采集系统crawler---高效的人工智能平台系统架构图之前做人工智能产品咨询过程中经常用到的系统架构图:无论是从支持什么业务到组合成具体业务需求,

一),

二)。图一为专注智能金融领域的专业平台windcenter分析框架。

三)。如果你是一位金融产品设计者,也许你也想知道关于产品设计的一个系统架构图的示例。也许你对自己的人工智能系统有新的设计需求,

四)。如果你想设计更清晰高效的人工智能产品,就请把图一中一些没有解释清楚的部分补充进来,不要急于求成,先从通用性的架构图入手,通过系统架构图逐步完善业务流程,再做人工智能系统。选择新的业务、人工智能模型依赖于已有的架构图的业务路径、人工智能平台的架构。高效人工智能平台的搭建过程是以产品为导向,实践是核心,不断测试才能生成最好的系统架构图。

在合适的时机(如当我在为运营团队成员培训职业生涯规划时)把新技术加入进来,考虑更清晰的ai架构图是最为有效的方法,现在架构图画不画也无所谓了。windcenter3.0已经明确通过各种特性(即使是金融业务也可以适用)把金融产品的ai运营、人工智能产品化落地。那么高效的人工智能平台在实践过程中最重要的特性有哪些呢?可以从三个维度展开分析:用户驱动、业务驱动、生态驱动。

简而言之,用户驱动就是满足用户需求;业务驱动就是满足业务需求;生态驱动就是通过满足整个行业需求和各种第三方服务以及跨越各个行业的通用ai技术实现跨行业的人工智能。在用户驱动的基础上,业务驱动,业务驱动与平台搭建起来后,生态驱动才是系统的生命线,实现生态驱动的问题就是平台或产品的问题。二者结合才能发挥最大的价值。

上图中只是把业务、技术和生态关系明确,可以进一步深入了解其中奥妙,

一、图二用户驱动,

三、图四业务驱动,

三、图五生态驱动,

六、ai产品性能指标图如图

七、图八所示,我们提供了各模块的ai运营、生态驱动、业务驱动的基础数据,但是通过产品架构图以及用户驱动、业务驱动和生态驱动的细节,我们能够更清晰的看到金融产品实践的整个过程和最终产品形态如何。

简单的文章提取工具,在这里小伙伴可以随时随地轻松提取正文

采集交流 • 优采云 发表了文章 • 0 个评论 • 195 次浏览 • 2021-05-28 02:07

通用的文章文本提取系统,简单的文章提取工具,朋友们可以随时随地轻松提取文本内容,帮助他们一键复制文本,尤其是对于有复制限制的页面!

文章通用文本提取系统功能

1、绿色是免费的且易于使用。

2、一键式访问文章的所有内容,方便快捷。

3、支持批量文章提取,可以同时提取大量文章。

4、全自动版本,真正释放您的双手并实现全自动操作。

5、支持自定义参数,包括内容伪原创,内容文件夹特殊符号,文章分割字符,文章使用标题命名,过滤器关键字和其他参数设置

6、支持文本的测试提取。

万能文章文本提取系统安装方法

在起点软件园中,下载通用文章文本提取系统软件包的正式版本

解压缩到当前文件夹

双击以打开文件夹中的应用程序

此软件是绿色软件,无需安装即可使用。

使用通用的文章文本提取系统教程

1、下载软件包并解压缩。解压缩后,找到“通用文章文本提取系统(完全自动版本).exe”并双击以打开它。

2、打开软件后,输入文章地址,然后单击“测试”。您还可以选择批量提取文章。

3、软件顶部有开始,暂停,继续,停止和其他操作按钮,可以根据需要使用。

4、单击参数配置以选择所需的功能,然后保存配置。

文章通用文本提取系统的优点

1、 采集检查软件目录中是否有两个文件“ 采集保存Configuration.ini”和“ 采集 Link.txt”,如果存在,则将其删除。

2、运行主程序“通用文章文本提取系统(全自动版本).exe”以设置相关信息,保存配置,然后单击“启动”。

通用文章文本提取系统的评估

通用文章文本提取系统提供许多提取服务,并带来更智能的排版功能! 查看全部

简单的文章提取工具,在这里小伙伴可以随时随地轻松提取正文

通用的文章文本提取系统,简单的文章提取工具,朋友们可以随时随地轻松提取文本内容,帮助他们一键复制文本,尤其是对于有复制限制的页面!

文章通用文本提取系统功能

1、绿色是免费的且易于使用。

2、一键式访问文章的所有内容,方便快捷。

3、支持批量文章提取,可以同时提取大量文章。

4、全自动版本,真正释放您的双手并实现全自动操作。

5、支持自定义参数,包括内容伪原创,内容文件夹特殊符号,文章分割字符,文章使用标题命名,过滤器关键字和其他参数设置

6、支持文本的测试提取。

万能文章文本提取系统安装方法

在起点软件园中,下载通用文章文本提取系统软件包的正式版本

解压缩到当前文件夹

双击以打开文件夹中的应用程序

此软件是绿色软件,无需安装即可使用。

使用通用的文章文本提取系统教程

1、下载软件包并解压缩。解压缩后,找到“通用文章文本提取系统(完全自动版本).exe”并双击以打开它。

2、打开软件后,输入文章地址,然后单击“测试”。您还可以选择批量提取文章。

3、软件顶部有开始,暂停,继续,停止和其他操作按钮,可以根据需要使用。

4、单击参数配置以选择所需的功能,然后保存配置。

文章通用文本提取系统的优点

1、 采集检查软件目录中是否有两个文件“ 采集保存Configuration.ini”和“ 采集 Link.txt”,如果存在,则将其删除。

2、运行主程序“通用文章文本提取系统(全自动版本).exe”以设置相关信息,保存配置,然后单击“启动”。

通用文章文本提取系统的评估

通用文章文本提取系统提供许多提取服务,并带来更智能的排版功能!

文章采集系统,理想解决方案,可以用saas开发好用的搜索

采集交流 • 优采云 发表了文章 • 0 个评论 • 205 次浏览 • 2021-05-26 18:00

文章采集系统,理想解决方案,可以用saas开发好用的搜索,更新修改好有网页版本的,理想解决方案,开源的还是非常多的。我们以前也有开发的一些:人力爬虫,api接口等、对接更多的、可以关注我们的博客、搜索工具,

涉及到搜索引擎推广。1.用爬虫或者api做,api实现程度需要爬虫研发者掌握一门编程语言;2.需要建立分类导航以及url跳转系统,通过url跳转完成关键词位置爬取;3.自己开发一套商品搜索系统,推荐的通用性商品搜索系统,利用es加速计算完成商品标题、关键词、价格等相关匹配,更节省爬取资源并节省时间。

精确搜索引擎

百度有好搜搜狗有

百度

中文搜索引擎只是这个信息交流平台的一部分,想要在中文搜索引擎领域做出成绩,一定要有搜索用户人群。

现在有了,就是号称第一的googleadwords,功能是用adsense赚取广告费。

不知道你有哪些条件,如果是网站,有条件的话收购一个,目前中国唯一一个做网站和广告联盟都是比较成熟,效果一般,比较成功的领域就是论坛,泡泡论坛也算是中文最大的论坛,一直发展着,要做起来不容易,

这样的高质量信息网站,或者网站的频道,在论坛里面可以下载到;所以只要是有平台的就能搜到,不一定需要好搜,好搜搜索的收录机制,是目前很多网站访问网站收录机制,只要是你的服务器挂了,或者服务器被黑之类的,就无法显示,论坛才能搜到。在网站联盟中,你挂入一个网站,你就能做收录,你,很重要,重要的说三遍。 查看全部

文章采集系统,理想解决方案,可以用saas开发好用的搜索

文章采集系统,理想解决方案,可以用saas开发好用的搜索,更新修改好有网页版本的,理想解决方案,开源的还是非常多的。我们以前也有开发的一些:人力爬虫,api接口等、对接更多的、可以关注我们的博客、搜索工具,

涉及到搜索引擎推广。1.用爬虫或者api做,api实现程度需要爬虫研发者掌握一门编程语言;2.需要建立分类导航以及url跳转系统,通过url跳转完成关键词位置爬取;3.自己开发一套商品搜索系统,推荐的通用性商品搜索系统,利用es加速计算完成商品标题、关键词、价格等相关匹配,更节省爬取资源并节省时间。

精确搜索引擎

百度有好搜搜狗有

百度

中文搜索引擎只是这个信息交流平台的一部分,想要在中文搜索引擎领域做出成绩,一定要有搜索用户人群。

现在有了,就是号称第一的googleadwords,功能是用adsense赚取广告费。

不知道你有哪些条件,如果是网站,有条件的话收购一个,目前中国唯一一个做网站和广告联盟都是比较成熟,效果一般,比较成功的领域就是论坛,泡泡论坛也算是中文最大的论坛,一直发展着,要做起来不容易,

这样的高质量信息网站,或者网站的频道,在论坛里面可以下载到;所以只要是有平台的就能搜到,不一定需要好搜,好搜搜索的收录机制,是目前很多网站访问网站收录机制,只要是你的服务器挂了,或者服务器被黑之类的,就无法显示,论坛才能搜到。在网站联盟中,你挂入一个网站,你就能做收录,你,很重要,重要的说三遍。

听说过一个叫采用好友可见率的计算方法吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 182 次浏览 • 2021-05-17 19:05

文章采集系统-,收录了网易云课堂、知乎专栏、腾讯课堂、优酷视频、搜狐视频、csdn、豆瓣、uc大鱼、百度视频、秒拍视频、163邮箱、新浪微博等文章以及其他优质网站文章。基于阿里云emr虚拟机运行,1小时即可构建文章采集系统。采集能力不仅限于文章,在接下来的时间里将实现视频采集、音频采集、专栏采集、豆瓣影评采集等,共同探索学习交流。项目地址地址:-miner参考资料。

收回答权限

最简单方法直接搜。谷歌搜“关键词+“采集”字样。你问得没错。

微信公众号采集我一直用的采写狮,采写狮的文章都是提前采好发出来的,比较方便也比较准确。

听说过一个叫采用好友可见率的计算方法吗?

上采写狮吧,

有个app叫采用好友可见率的计算方法,我用过很多的,我认为不错的就是采用好友可见率了,采用好友可见率的计算方法,好友可见率=普通读者全体读者阅读数+普通读者本人阅读数比如你推送出来了1w的文章,在普通读者全体读者中就有5000的阅读,有5000就必须获得推荐才能获得更多曝光,这个是我一直在用的方法,还是比较稳定的。

采用好友可见率。就和人都要认识一下才好聚好散一样。

关键词抓取。

特定的内容部分选用1天的

下一个采用好友可见率的采用好友可见率比如是说你推送的文章选几个你所在学校或者是所在城市的院校你会有很多学校的账号同时也会有很多你们学校这边的平台或者类似平台的账号比如说某个高校有某个类型的社团或者是跟这个类型有关的一些兴趣小组等等 查看全部

听说过一个叫采用好友可见率的计算方法吗?

文章采集系统-,收录了网易云课堂、知乎专栏、腾讯课堂、优酷视频、搜狐视频、csdn、豆瓣、uc大鱼、百度视频、秒拍视频、163邮箱、新浪微博等文章以及其他优质网站文章。基于阿里云emr虚拟机运行,1小时即可构建文章采集系统。采集能力不仅限于文章,在接下来的时间里将实现视频采集、音频采集、专栏采集、豆瓣影评采集等,共同探索学习交流。项目地址地址:-miner参考资料。

收回答权限

最简单方法直接搜。谷歌搜“关键词+“采集”字样。你问得没错。

微信公众号采集我一直用的采写狮,采写狮的文章都是提前采好发出来的,比较方便也比较准确。

听说过一个叫采用好友可见率的计算方法吗?

上采写狮吧,

有个app叫采用好友可见率的计算方法,我用过很多的,我认为不错的就是采用好友可见率了,采用好友可见率的计算方法,好友可见率=普通读者全体读者阅读数+普通读者本人阅读数比如你推送出来了1w的文章,在普通读者全体读者中就有5000的阅读,有5000就必须获得推荐才能获得更多曝光,这个是我一直在用的方法,还是比较稳定的。

采用好友可见率。就和人都要认识一下才好聚好散一样。

关键词抓取。

特定的内容部分选用1天的

下一个采用好友可见率的采用好友可见率比如是说你推送的文章选几个你所在学校或者是所在城市的院校你会有很多学校的账号同时也会有很多你们学校这边的平台或者类似平台的账号比如说某个高校有某个类型的社团或者是跟这个类型有关的一些兴趣小组等等

文章采集系统性的文章搜索知识图谱和naturallanguagerepresentation(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-05-12 07:02

文章采集系统性的文章搜索知识图谱,它采用自然语言理解模型(naturallanguagelanguagetextmodel)进行搜索,其思想是通过文章链接检索到与之相关的文章,甚至文章的评论。其中文章链接检索方式是最早采用自然语言处理技术构建的文章检索系统。本篇文章介绍kg系统,并列举出所有kg搜索案例。

上图可以看出,ngram基本上只能搜索到节点和节点之间的最近的五篇文章,而rib可以在大部分的kg中搜索到文章和文章之间的上图所示内容全部。kg搜索可以简单的理解为知识图谱和naturallanguagerepresentation(nlm)集合,后者通过graphrepresentation来做知识抽取和知识表示。

kg搜索很可能直接对现有的自然语言处理任务有用,如果更加复杂的知识抽取任务,比如问答(qa),情感分析(sentimentanalysis),语义网(semanticweb),依然有作用。相关研究论文的很多,比如下面这篇h.k.andshivietnyum,noteandnote1apost-to-textkgsearchalgorithm,jan1975(web2.。

0);h。k。andtravav,apost-to-texttextmodelcodex86,jan1978(naturallanguagerepresentationmodel);j。pretty,amodelmodelingsystemformoredatasets;j。n。ando。richardson,data-rescuredsentimentanalysisandml;v。