文章采集系统

文章采集系统(浏览器览器采集公众号文章的方案有哪些吗?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2021-12-12 22:22

浏览器采集公众号文章有哪些解决方法?采集系统组件有哪些?关键词:浏览器采集公众号文章 说明:公众号平台上发布的很多文章来自其他人采集。你知道浏览器采集公众号文章有哪些解决方法吗?另外,采集 系统的组成部分是什么?今天就用拖图数据编辑器来看看吧。公众号平台上发布的许多文章来自其他人采集。你知道浏览器采集公众号文章有哪些解决方法吗?另外,采集 系统的组成部分是什么?今天就和拓图数据编辑器一起来看看吧。. 浏览器采集公众账号文章 方案一:根据搜狗门户在网上可以搜索到的公众号文章采集的相关信息,这是最、最直接、最简单的解决方案。浏览器采集公众号文章 一般流程是:在搜狗微信搜索门户搜索公众号,选择公众号进入公众号历史文章列表,分析内容文章 并存入数据库采集如果过于频繁,验证码会出现在搜狗搜索和公众账号历史文章列表访问中。直接使用通用脚本采集是无法获取验证码的。这里可以使用无头浏览器访问,通过对接编码平台识别验证码。Selenium 可以用作无头浏览器。即使使用无头浏览器,也存在以下问题: 效率低下(实际运行一个完整的浏览器来模拟人工操作) 浏览器中网页资源的加载难以控制,脚本难以控制加载无法进行浏览器和验证码识别。到100%,爬取过程很可能中途中断。如果坚持使用搜狗门户,想要完善采集,只能增加代理IP。并且脚本难以控制浏览器的加载,无法进行验证码识别。到100%,爬取过程很可能中途中断。如果坚持使用搜狗门户,想要完善采集,只能增加代理IP。并且脚本难以控制浏览器的加载,无法进行验证码识别。到100%,爬取过程很可能中途中断。如果坚持使用搜狗门户,想要完善采集,只能增加代理IP。

顺便说一句,甚至不要考虑公开一个免费的 IP 地址。很不稳定,基本被微信屏蔽了。除了搜狗/微信反爬虫机制外,采用该方案还有其他不足: 无法获取阅读数、点赞数等用于评价文章质量的关键信息是无法及时获取已发布的公众号文章,只能定期重复爬取,只能获取最近十个群发帖文章 解决方案二:网页微信抓包分析后被微信反爬虫滥用找了半天,和同事集思广益,找到了新的微信公众号文章爬取程序。只需分析哪些门户可以获取数据。Fuzzy记得网络微信有个公众号文章 阅读功能。碰巧玩了一段时间的个人微信,主要是使用Python包ItChat。其实现原理是对网页微信进行抓取分析,汇总成个人微信界面。目标是实现网页微信能实现的所有功能。. 所以有一个初步的计划——通过ItChat让微信公众号文章推送过来。我快下班的时候跟同事提过。他也很感兴趣。第二天就实现了验证码(ItChat对应功能码的实现很简略,内容分析部分是在内容分析部分可以直接使用之前做的)。这个解决方案的主要过程是:服务器通过ItChat登录网页微信。当公众号发布新的文章推送时,会被服务器拦截进行后续分析和存储。这种方案的优点是: 基本零间隔获取已发布的公众号文章 获取点赞数和阅读数,只需要登录手机微信即可,无需其他操作。当然,也有缺点:需要长期联网的手机。时间滴采集 系统由以下部分组成: 1、 微信客户端:可以是安装了微信app的手机,也可以是电脑中的安卓模拟器。这种方案的优点是: 基本零间隔获取已发布的公众号文章 获取点赞数和阅读数,只需要登录手机微信即可,无需其他操作。当然,也有缺点:需要长期联网的手机。时间滴采集 系统由以下部分组成: 1、 微信客户端:可以是安装了微信app的手机,也可以是电脑中的安卓模拟器。这种方案的优点是: 基本零间隔获取已发布的公众号文章 获取点赞数和阅读数,只需要登录手机微信即可,无需其他操作。当然,也有缺点:需要长期联网的手机。时间滴采集 系统由以下部分组成: 1、 微信客户端:可以是安装了微信app的手机,也可以是电脑中的安卓模拟器。

ios的微信客户端在批处理采集过程中,实际测试后崩溃率高于Android系统。为了降低成本,我使用了Android模拟器。2、一个微信个人号:采集的内容不仅需要一个微信客户端,还需要一个专用于采集的微信个人号,因为这个微信号不能做其他事情. 3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众号历史消息页面中的文章列表发送到您的服务器。具体的安装方法后面会详细介绍。浏览器采集公众号文章 4、文章 列表分析和存储系统:我用php语言写的,下面的文章将详细讲解如何分析文章List,创建采集队列,实现批量采集内容。看了上面的拓图数据编辑器的介绍,相信大家对浏览器采集公众号文章以及采集系统的组成有了一定的了解。有些文章应该经常在公众号平台上发表。采集使用采集系统可以更加方便快捷。继续关注更多资讯和知识点,关注微信公众号原创文章统计,关于微信公众号原创< @文章how 统计等知识点,如何批量导出微信文件, 查看全部

文章采集系统(浏览器览器采集公众号文章的方案有哪些吗?)

浏览器采集公众号文章有哪些解决方法?采集系统组件有哪些?关键词:浏览器采集公众号文章 说明:公众号平台上发布的很多文章来自其他人采集。你知道浏览器采集公众号文章有哪些解决方法吗?另外,采集 系统的组成部分是什么?今天就用拖图数据编辑器来看看吧。公众号平台上发布的许多文章来自其他人采集。你知道浏览器采集公众号文章有哪些解决方法吗?另外,采集 系统的组成部分是什么?今天就和拓图数据编辑器一起来看看吧。. 浏览器采集公众账号文章 方案一:根据搜狗门户在网上可以搜索到的公众号文章采集的相关信息,这是最、最直接、最简单的解决方案。浏览器采集公众号文章 一般流程是:在搜狗微信搜索门户搜索公众号,选择公众号进入公众号历史文章列表,分析内容文章 并存入数据库采集如果过于频繁,验证码会出现在搜狗搜索和公众账号历史文章列表访问中。直接使用通用脚本采集是无法获取验证码的。这里可以使用无头浏览器访问,通过对接编码平台识别验证码。Selenium 可以用作无头浏览器。即使使用无头浏览器,也存在以下问题: 效率低下(实际运行一个完整的浏览器来模拟人工操作) 浏览器中网页资源的加载难以控制,脚本难以控制加载无法进行浏览器和验证码识别。到100%,爬取过程很可能中途中断。如果坚持使用搜狗门户,想要完善采集,只能增加代理IP。并且脚本难以控制浏览器的加载,无法进行验证码识别。到100%,爬取过程很可能中途中断。如果坚持使用搜狗门户,想要完善采集,只能增加代理IP。并且脚本难以控制浏览器的加载,无法进行验证码识别。到100%,爬取过程很可能中途中断。如果坚持使用搜狗门户,想要完善采集,只能增加代理IP。

顺便说一句,甚至不要考虑公开一个免费的 IP 地址。很不稳定,基本被微信屏蔽了。除了搜狗/微信反爬虫机制外,采用该方案还有其他不足: 无法获取阅读数、点赞数等用于评价文章质量的关键信息是无法及时获取已发布的公众号文章,只能定期重复爬取,只能获取最近十个群发帖文章 解决方案二:网页微信抓包分析后被微信反爬虫滥用找了半天,和同事集思广益,找到了新的微信公众号文章爬取程序。只需分析哪些门户可以获取数据。Fuzzy记得网络微信有个公众号文章 阅读功能。碰巧玩了一段时间的个人微信,主要是使用Python包ItChat。其实现原理是对网页微信进行抓取分析,汇总成个人微信界面。目标是实现网页微信能实现的所有功能。. 所以有一个初步的计划——通过ItChat让微信公众号文章推送过来。我快下班的时候跟同事提过。他也很感兴趣。第二天就实现了验证码(ItChat对应功能码的实现很简略,内容分析部分是在内容分析部分可以直接使用之前做的)。这个解决方案的主要过程是:服务器通过ItChat登录网页微信。当公众号发布新的文章推送时,会被服务器拦截进行后续分析和存储。这种方案的优点是: 基本零间隔获取已发布的公众号文章 获取点赞数和阅读数,只需要登录手机微信即可,无需其他操作。当然,也有缺点:需要长期联网的手机。时间滴采集 系统由以下部分组成: 1、 微信客户端:可以是安装了微信app的手机,也可以是电脑中的安卓模拟器。这种方案的优点是: 基本零间隔获取已发布的公众号文章 获取点赞数和阅读数,只需要登录手机微信即可,无需其他操作。当然,也有缺点:需要长期联网的手机。时间滴采集 系统由以下部分组成: 1、 微信客户端:可以是安装了微信app的手机,也可以是电脑中的安卓模拟器。这种方案的优点是: 基本零间隔获取已发布的公众号文章 获取点赞数和阅读数,只需要登录手机微信即可,无需其他操作。当然,也有缺点:需要长期联网的手机。时间滴采集 系统由以下部分组成: 1、 微信客户端:可以是安装了微信app的手机,也可以是电脑中的安卓模拟器。

ios的微信客户端在批处理采集过程中,实际测试后崩溃率高于Android系统。为了降低成本,我使用了Android模拟器。2、一个微信个人号:采集的内容不仅需要一个微信客户端,还需要一个专用于采集的微信个人号,因为这个微信号不能做其他事情. 3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众号历史消息页面中的文章列表发送到您的服务器。具体的安装方法后面会详细介绍。浏览器采集公众号文章 4、文章 列表分析和存储系统:我用php语言写的,下面的文章将详细讲解如何分析文章List,创建采集队列,实现批量采集内容。看了上面的拓图数据编辑器的介绍,相信大家对浏览器采集公众号文章以及采集系统的组成有了一定的了解。有些文章应该经常在公众号平台上发表。采集使用采集系统可以更加方便快捷。继续关注更多资讯和知识点,关注微信公众号原创文章统计,关于微信公众号原创< @文章how 统计等知识点,如何批量导出微信文件,

文章采集系统(一个微信公众号历史消息页面的链接地址和采集方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 163 次浏览 • 2021-12-08 21:13

2014年开始做微信公众号内容的批量采集,最初的目的是为了制作html5垃圾邮件网站。当时,垃圾站采集到达的微信公众号内容很容易在公众号传播。那个时候分批的采集特别好做,而采集的入口就是公众号的历史新闻页面。这个入口现在还是一样,只是越来越难采集。采集的方法也更新了很多版本。后来到了2015年,html5垃圾站就不做了。取而代之的是,采集的目标是针对本地新闻资讯公众号,将前端展示做成一个app。所以一个可以自动< @采集 公众号内容形成。曾经担心微信技术升级一天后,采集的内容不可用,我的新闻应用会失败。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。

本文文章会持续更新,保证您看到的内容在您看到时可用。

首先我们来看一个微信公众号历史消息页面的链接地址:

http://mp.weixin.qq.com/mp/get ... irect

========2017 年 1 月 11 日更新 ==========

现在,根据不同的微信个人账号,会有两个不同的历史消息页面地址。以下是另一个历史消息页面的地址。第一种地址的链接在anyproxy中会显示302跳转:

https://mp.weixin.qq.com/mp/pr ... irect

第一个链接地址的页面样式:

第二个链接地址的页面样式:

根据目前掌握的信息,这两种页面格式在不同的微信账号中出现不规则。有的微信账号永远是第一页格式,有的永远是第二页格式。

上面的链接是微信公众号历史新闻页面的真实链接,但是当我们在浏览器中输入这个链接时,会显示:请从微信客户端访问。这是因为链接地址实际上需要几个参数才能正常显示内容。我们来看看一个完整的链接,可以正常显示内容的样子:

//第一种链接

http://mp.weixin.qq.com/mp/get ... r%3D1

//第二种

http://mp.weixin.qq.com/mp/pro ... r%3D1

该地址是通过微信客户端打开历史消息页面后,使用后面介绍的代理服务器软件获取的。有几个参数:

action=;__biz=;uin=;key=;devicetype=;version=;lang=;nettype=;scene=;pass_ticket=;wx_header=;

重要的参数是:__biz;uin=;key=;pass_ticket=; 这4个参数。

__biz 是公众号的类似id的参数。每个公众号都有一个微信。目前公众号的biz变动的可能性很小;

剩下的3个参数与用户的id和tokenticket的含义有关。这3个参数的值在微信客户端生成后会自动添加到地址栏。所以我们认为采集公众号必须通过微信客户端。在之前的微信版本中,这3个参数也可以一次性获取,在有效期内可以使用多个公众号。在当前版本中,每次访问公众号时都会更改参数值。

我现在使用的方法只需要关注__biz参数即可。

我的采集系统由以下部分组成:

1、 微信客户端:可以是安装了微信应用的手机,也可以是电脑中的安卓模拟器。在batch采集上测试的ios微信客户端崩溃率高于Android系统。为了降低成本,我使用了Android模拟器。

2、一个微信个人号:采集的内容不仅需要一个微信客户端,还需要一个专用于采集的微信个人号,因为这个微信号不能做其他事情.

3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众号历史消息页面中文章的列表发送到自己的服务器上。具体的安装方法后面会详细介绍。

4、文章列表分析入库系统:本人使用PHP语言编写,下篇文章将详细介绍如何分析文章列表并建立采集队列来实现批次采集内容。

步

一、 安装模拟器或使用手机安装微信客户端APP,申请微信个人账号并登录APP。这个我就不多介绍了,大家自己做。

二、代理服务器系统安装

目前我使用 Anyproxy,AnyProxy。这个软件的特点是可以获取https链接的内容。2016年初,微信公众号和微信文章开始使用https链接。而Anyproxy可以通过修改规则配置,在公众号页面插入脚本代码。下面将介绍安装和配置过程。

1、安装NodeJS

2、 在命令行或终端运行npm install -g anyproxy,mac系统需要添加sudo;

3、 生成RootCA,https需要这个证书:运行命令sudo anyproxy --root(windows可能不需要sudo);

4、 启动 anyproxy 运行命令:sudo anyproxy -i; 参数-i表示解析HTTPS;

5、安装证书,在手机或者安卓模拟器安装证书:

6、 设置代理:安卓模拟器的代理服务器地址是wifi链接的网关。通过dhcp设置为static后就可以看到网关地址了。阅读后不要忘记将其设置为自动。手机中的代理服务器地址是运行anyproxy的电脑的ip地址。代理服务器默认端口为8001;

现在打开微信,点击任意公众号历史消息或者文章,就可以看到在终端滚动的响应码。如果没有出现,请检查手机的代理设置是否正确。

现在打开浏览器地址localhost:8002就可以看到anyproxy的web界面了。从微信点击打开历史消息页面,然后在浏览器的web界面查看历史消息页面的地址会滚动。

/mp/getmasssendmsg开头的网址是微信历史消息页面。左边的小锁表示这个页面是 https 加密的。现在我们点击这一行;

========2017 年 1 月 11 日更新 ==========

一些以/mp/getmasssendmsg开头的微信网址会出现302跳转到/mp/profile_ext?action=home开头的地址。所以点击这个地址可以看到内容。

如果右侧出现html文件的内容,则说明解密成功。如果没有内容,请检查anyproxy运行方式是否有参数i,是否生成了ca证书,是否在手机上正确安装了证书。

现在我们手机中的所有内容都可以明文通过代理服务器了。接下来,我们需要修改代理服务器的配置,以便获取公众号的内容。

一、找到配置文件:

mac系统中配置文件的位置是/usr/local/lib/node_modules/anyproxy/lib/;对于windows系统,不知道还请见谅。根据类似mac的文件夹地址应该可以找到这个目录。

二、修改文件rule_default.js

找到 replaceServerResDataAsync: function(req,res,serverResData,callback) 函数

修改函数内容(请详细阅读注释,这里只是介绍原理,理解后根据自己的情况修改内容):

========2017 年 1 月 11 日更新 ==========

因为有两种页面格式,相同的页面格式总是显示在不同的微信账号中,但是为了兼容两种页面格式,下面的代码会保留两种页面格式的判断。您也可以使用自己的页面从表单中删除 li

replaceServerResDataAsync: function(req,res,serverResData,callback){

if(/mp\/getmasssendmsg/i.test(req.url)){//当链接地址为公众号历史消息页面时(第一种页面形式)

if(serverResData.toString() !== ""){

try {//防止报错退出程序

var reg = /msgList = (.*?);\r\n/;//定义历史消息正则匹配规则

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis.php', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){//如果上面的正则没有匹配到,那么这个页面内容可能是公众号历史消息页面向下翻动的第二页,因为历史消息第一页是html格式的,第二页就是json格式的。

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);//错误捕捉

}

callback(serverResData);//直接返回第二页json内容

}

}

}else if(/mp\/profile_ext\?action=home/i.test(req.url)){//当链接地址为公众号历史消息页面时(第二种页面形式)

try {

var reg = /var msgList = \'(.*?)\';\r\n/;//定义历史消息正则匹配规则(和第一种页面形式的正则不同)

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){

callback(serverResData);

}

}else if(/mp\/profile_ext\?action=getmsg/i.test(req.url)){//第二种页面表现形式的向下翻页后的json

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);

}

callback(serverResData);

}else if(/mp\/getappmsgext/i.test(req.url)){//当链接地址为公众号文章阅读量和点赞量时

try {

HttpPost(serverResData,req.url,"getMsgExt.php");//函数是后文定义的,功能是将文章阅读量点赞量的json发送到服务器

}catch(e){

}

callback(serverResData);

}else if(/s\?__biz/i.test(req.url) || /mp\/rumor/i.test(req.url)){//当链接地址为公众号文章时(rumor这个地址是公众号文章被辟谣了)

try {

var http = require('http');

http.get('http://xxx.com/getWxPost.php', function(res) {//这个地址是自己服务器上的另一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxPost.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);

})

});

}catch(e){

callback(serverResData);

}

}else{

callback(serverResData);

}

},

上面的代码就是使用anyproxy修改了返回页面内容、向页面注入脚本、将页面内容发送到服务器的功能。利用这个原理批量处理采集公众号内容和阅读量。该脚本中自定义了一个函数,详细说明如下:

在 rule_default.js 文件的末尾添加以下代码:

function HttpPost(str,url,path) {//将json发送到服务器,str为json内容,url为历史消息页面地址,path是接收程序的路径和文件名

var http = require('http');

var data = {

str: encodeURIComponent(str),

url: encodeURIComponent(url)

};

content = require('querystring').stringify(data);

var options = {

method: "POST",

host: "www.xxx.com",//注意没有http://,这是服务器的域名。

port: 80,

path: path,//接收程序的路径和文件名

headers: {

'Content-Type': 'application/x-www-form-urlencoded; charset=UTF-8',

"Content-Length": content.length

}

};

var req = http.request(options, function (res) {

res.setEncoding('utf8');

res.on('data', function (chunk) {

console.log('BODY: ' + chunk);

});

});

req.on('error', function (e) {

console.log('problem with request: ' + e.message);

});

req.write(content);

req.end();

}

以上是规则修改的主要部分。您需要将json内容发送到您自己的服务器,并从服务器获取到下一页的跳转地址。这涉及到四个php文件:getMsgJson.php、getMsgExt.php、getWxHis.php、getWxPost.php

在详细介绍这4个php文件之前,为了提高采集系统性能,降低崩溃率,我们还可以做一些修改:

Android模拟器经常访问一些地址,会导致anyproxy崩溃,找到函数replaceRequestOption:function(req,option),修改函数内容:

replaceRequestOption : function(req,option){

var newOption = option;

if(/google/i.test(newOption.headers.host)){

newOption.hostname = "www.baidu.com";

newOption.port = "80";

}

return newOption;

},

以上是对anyproxy规则文件的修改配置。配置修改完成后,重启anyproxy。在mac系统下,按control+c中断程序,然后输入命令sudo anyproxy -i启动;如果报错,程序可能无法干净退出,端口被占用。这时候输入命令ps -a查看占用的pid,然后输入命令“kill -9 pid”将pid替换为查询到的pid号。杀掉进程后,就可以启动anyproxy了。再次请原谅我不熟悉windows命令。

接下来详细介绍服务器端接收程序的设计原理:

(以下代码不能直接使用,只介绍原理,部分需要根据自己的服务器数据库框架编写)

1、getMsgJson.php:该程序负责接收历史消息的json,解析并存入数据库

<p> 查看全部

文章采集系统(一个微信公众号历史消息页面的链接地址和采集方法)

2014年开始做微信公众号内容的批量采集,最初的目的是为了制作html5垃圾邮件网站。当时,垃圾站采集到达的微信公众号内容很容易在公众号传播。那个时候分批的采集特别好做,而采集的入口就是公众号的历史新闻页面。这个入口现在还是一样,只是越来越难采集。采集的方法也更新了很多版本。后来到了2015年,html5垃圾站就不做了。取而代之的是,采集的目标是针对本地新闻资讯公众号,将前端展示做成一个app。所以一个可以自动< @采集 公众号内容形成。曾经担心微信技术升级一天后,采集的内容不可用,我的新闻应用会失败。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。

本文文章会持续更新,保证您看到的内容在您看到时可用。

首先我们来看一个微信公众号历史消息页面的链接地址:

http://mp.weixin.qq.com/mp/get ... irect

========2017 年 1 月 11 日更新 ==========

现在,根据不同的微信个人账号,会有两个不同的历史消息页面地址。以下是另一个历史消息页面的地址。第一种地址的链接在anyproxy中会显示302跳转:

https://mp.weixin.qq.com/mp/pr ... irect

第一个链接地址的页面样式:

第二个链接地址的页面样式:

根据目前掌握的信息,这两种页面格式在不同的微信账号中出现不规则。有的微信账号永远是第一页格式,有的永远是第二页格式。

上面的链接是微信公众号历史新闻页面的真实链接,但是当我们在浏览器中输入这个链接时,会显示:请从微信客户端访问。这是因为链接地址实际上需要几个参数才能正常显示内容。我们来看看一个完整的链接,可以正常显示内容的样子:

//第一种链接

http://mp.weixin.qq.com/mp/get ... r%3D1

//第二种

http://mp.weixin.qq.com/mp/pro ... r%3D1

该地址是通过微信客户端打开历史消息页面后,使用后面介绍的代理服务器软件获取的。有几个参数:

action=;__biz=;uin=;key=;devicetype=;version=;lang=;nettype=;scene=;pass_ticket=;wx_header=;

重要的参数是:__biz;uin=;key=;pass_ticket=; 这4个参数。

__biz 是公众号的类似id的参数。每个公众号都有一个微信。目前公众号的biz变动的可能性很小;

剩下的3个参数与用户的id和tokenticket的含义有关。这3个参数的值在微信客户端生成后会自动添加到地址栏。所以我们认为采集公众号必须通过微信客户端。在之前的微信版本中,这3个参数也可以一次性获取,在有效期内可以使用多个公众号。在当前版本中,每次访问公众号时都会更改参数值。

我现在使用的方法只需要关注__biz参数即可。

我的采集系统由以下部分组成:

1、 微信客户端:可以是安装了微信应用的手机,也可以是电脑中的安卓模拟器。在batch采集上测试的ios微信客户端崩溃率高于Android系统。为了降低成本,我使用了Android模拟器。

2、一个微信个人号:采集的内容不仅需要一个微信客户端,还需要一个专用于采集的微信个人号,因为这个微信号不能做其他事情.

3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众号历史消息页面中文章的列表发送到自己的服务器上。具体的安装方法后面会详细介绍。

4、文章列表分析入库系统:本人使用PHP语言编写,下篇文章将详细介绍如何分析文章列表并建立采集队列来实现批次采集内容。

步

一、 安装模拟器或使用手机安装微信客户端APP,申请微信个人账号并登录APP。这个我就不多介绍了,大家自己做。

二、代理服务器系统安装

目前我使用 Anyproxy,AnyProxy。这个软件的特点是可以获取https链接的内容。2016年初,微信公众号和微信文章开始使用https链接。而Anyproxy可以通过修改规则配置,在公众号页面插入脚本代码。下面将介绍安装和配置过程。

1、安装NodeJS

2、 在命令行或终端运行npm install -g anyproxy,mac系统需要添加sudo;

3、 生成RootCA,https需要这个证书:运行命令sudo anyproxy --root(windows可能不需要sudo);

4、 启动 anyproxy 运行命令:sudo anyproxy -i; 参数-i表示解析HTTPS;

5、安装证书,在手机或者安卓模拟器安装证书:

6、 设置代理:安卓模拟器的代理服务器地址是wifi链接的网关。通过dhcp设置为static后就可以看到网关地址了。阅读后不要忘记将其设置为自动。手机中的代理服务器地址是运行anyproxy的电脑的ip地址。代理服务器默认端口为8001;

现在打开微信,点击任意公众号历史消息或者文章,就可以看到在终端滚动的响应码。如果没有出现,请检查手机的代理设置是否正确。

现在打开浏览器地址localhost:8002就可以看到anyproxy的web界面了。从微信点击打开历史消息页面,然后在浏览器的web界面查看历史消息页面的地址会滚动。

/mp/getmasssendmsg开头的网址是微信历史消息页面。左边的小锁表示这个页面是 https 加密的。现在我们点击这一行;

========2017 年 1 月 11 日更新 ==========

一些以/mp/getmasssendmsg开头的微信网址会出现302跳转到/mp/profile_ext?action=home开头的地址。所以点击这个地址可以看到内容。

如果右侧出现html文件的内容,则说明解密成功。如果没有内容,请检查anyproxy运行方式是否有参数i,是否生成了ca证书,是否在手机上正确安装了证书。

现在我们手机中的所有内容都可以明文通过代理服务器了。接下来,我们需要修改代理服务器的配置,以便获取公众号的内容。

一、找到配置文件:

mac系统中配置文件的位置是/usr/local/lib/node_modules/anyproxy/lib/;对于windows系统,不知道还请见谅。根据类似mac的文件夹地址应该可以找到这个目录。

二、修改文件rule_default.js

找到 replaceServerResDataAsync: function(req,res,serverResData,callback) 函数

修改函数内容(请详细阅读注释,这里只是介绍原理,理解后根据自己的情况修改内容):

========2017 年 1 月 11 日更新 ==========

因为有两种页面格式,相同的页面格式总是显示在不同的微信账号中,但是为了兼容两种页面格式,下面的代码会保留两种页面格式的判断。您也可以使用自己的页面从表单中删除 li

replaceServerResDataAsync: function(req,res,serverResData,callback){

if(/mp\/getmasssendmsg/i.test(req.url)){//当链接地址为公众号历史消息页面时(第一种页面形式)

if(serverResData.toString() !== ""){

try {//防止报错退出程序

var reg = /msgList = (.*?);\r\n/;//定义历史消息正则匹配规则

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis.php', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){//如果上面的正则没有匹配到,那么这个页面内容可能是公众号历史消息页面向下翻动的第二页,因为历史消息第一页是html格式的,第二页就是json格式的。

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);//错误捕捉

}

callback(serverResData);//直接返回第二页json内容

}

}

}else if(/mp\/profile_ext\?action=home/i.test(req.url)){//当链接地址为公众号历史消息页面时(第二种页面形式)

try {

var reg = /var msgList = \'(.*?)\';\r\n/;//定义历史消息正则匹配规则(和第一种页面形式的正则不同)

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){

callback(serverResData);

}

}else if(/mp\/profile_ext\?action=getmsg/i.test(req.url)){//第二种页面表现形式的向下翻页后的json

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);

}

callback(serverResData);

}else if(/mp\/getappmsgext/i.test(req.url)){//当链接地址为公众号文章阅读量和点赞量时

try {

HttpPost(serverResData,req.url,"getMsgExt.php");//函数是后文定义的,功能是将文章阅读量点赞量的json发送到服务器

}catch(e){

}

callback(serverResData);

}else if(/s\?__biz/i.test(req.url) || /mp\/rumor/i.test(req.url)){//当链接地址为公众号文章时(rumor这个地址是公众号文章被辟谣了)

try {

var http = require('http');

http.get('http://xxx.com/getWxPost.php', function(res) {//这个地址是自己服务器上的另一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxPost.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);

})

});

}catch(e){

callback(serverResData);

}

}else{

callback(serverResData);

}

},

上面的代码就是使用anyproxy修改了返回页面内容、向页面注入脚本、将页面内容发送到服务器的功能。利用这个原理批量处理采集公众号内容和阅读量。该脚本中自定义了一个函数,详细说明如下:

在 rule_default.js 文件的末尾添加以下代码:

function HttpPost(str,url,path) {//将json发送到服务器,str为json内容,url为历史消息页面地址,path是接收程序的路径和文件名

var http = require('http');

var data = {

str: encodeURIComponent(str),

url: encodeURIComponent(url)

};

content = require('querystring').stringify(data);

var options = {

method: "POST",

host: "www.xxx.com",//注意没有http://,这是服务器的域名。

port: 80,

path: path,//接收程序的路径和文件名

headers: {

'Content-Type': 'application/x-www-form-urlencoded; charset=UTF-8',

"Content-Length": content.length

}

};

var req = http.request(options, function (res) {

res.setEncoding('utf8');

res.on('data', function (chunk) {

console.log('BODY: ' + chunk);

});

});

req.on('error', function (e) {

console.log('problem with request: ' + e.message);

});

req.write(content);

req.end();

}

以上是规则修改的主要部分。您需要将json内容发送到您自己的服务器,并从服务器获取到下一页的跳转地址。这涉及到四个php文件:getMsgJson.php、getMsgExt.php、getWxHis.php、getWxPost.php

在详细介绍这4个php文件之前,为了提高采集系统性能,降低崩溃率,我们还可以做一些修改:

Android模拟器经常访问一些地址,会导致anyproxy崩溃,找到函数replaceRequestOption:function(req,option),修改函数内容:

replaceRequestOption : function(req,option){

var newOption = option;

if(/google/i.test(newOption.headers.host)){

newOption.hostname = "www.baidu.com";

newOption.port = "80";

}

return newOption;

},

以上是对anyproxy规则文件的修改配置。配置修改完成后,重启anyproxy。在mac系统下,按control+c中断程序,然后输入命令sudo anyproxy -i启动;如果报错,程序可能无法干净退出,端口被占用。这时候输入命令ps -a查看占用的pid,然后输入命令“kill -9 pid”将pid替换为查询到的pid号。杀掉进程后,就可以启动anyproxy了。再次请原谅我不熟悉windows命令。

接下来详细介绍服务器端接收程序的设计原理:

(以下代码不能直接使用,只介绍原理,部分需要根据自己的服务器数据库框架编写)

1、getMsgJson.php:该程序负责接收历史消息的json,解析并存入数据库

<p>

文章采集系统(一个微信公众号历史消息页面的链接地址和采集方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-12-08 21:06

2014年开始做微信公众号内容的批量采集,最初的目的是为了制作html5垃圾邮件网站。当时,垃圾站采集到达的微信公众号内容很容易在公众号传播。那个时候分批的采集特别好做,而采集的入口就是公众号的历史新闻页面。这个入口现在还是一样,只是越来越难采集。采集的方法也更新了很多版本。后来到了2015年,html5垃圾站就不做了。取而代之的是,采集的目标是针对本地新闻资讯公众号,将前端展示做成一个app。所以一个可以自动< @采集 公众号内容形成。曾经担心微信技术升级一天后,采集的内容不可用,我的新闻应用会失败。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。

本文文章会持续更新,保证您看到的内容在您看到时可用。

首先我们来看一个微信公众号历史消息页面的链接地址:

http://mp.weixin.qq.com/mp/get ... irect

========2017 年 1 月 11 日更新 ==========

现在,根据不同的微信个人账号,会有两个不同的历史消息页面地址。以下是另一个历史消息页面的地址。第一种地址的链接在anyproxy中会显示302跳转:

https://mp.weixin.qq.com/mp/pr ... irect

第一个链接地址的页面样式:

第二个链接地址的页面样式:

根据目前掌握的信息,这两种页面格式在不同的微信账号中出现不规则。有的微信账号永远是第一页格式,有的永远是第二页格式。

上面的链接是微信公众号历史新闻页面的真实链接,但是当我们在浏览器中输入这个链接时,会显示:请从微信客户端访问。这是因为链接地址实际上需要几个参数才能正常显示内容。我们来看看一个完整的链接,可以正常显示内容的样子:

//第一种链接

http://mp.weixin.qq.com/mp/get ... r%3D1

//第二种

http://mp.weixin.qq.com/mp/pro ... r%3D1

该地址是通过微信客户端打开历史消息页面后,使用后面介绍的代理服务器软件获取的。有几个参数:

action=;__biz=;uin=;key=;devicetype=;version=;lang=;nettype=;scene=;pass_ticket=;wx_header=;

重要的参数是:__biz;uin=;key=;pass_ticket=; 这4个参数。

__biz 是公众号的类似id的参数。每个公众号都有一个微信。目前公众号的biz变动的可能性很小;

剩下的3个参数与用户的id和tokenticket的含义有关。这3个参数的值在微信客户端生成后会自动添加到地址栏。所以我们认为采集公众号必须通过微信客户端。在之前的微信版本中,这3个参数也可以一次性获取,在有效期内可以使用多个公众号。在当前版本中,每次访问公众号时都会更改参数值。

我现在使用的方法只需要关注__biz参数即可。

我的采集系统由以下部分组成:

1、 微信客户端:可以是安装了微信应用的手机,也可以是电脑中的安卓模拟器。在batch采集上测试的ios微信客户端崩溃率高于Android系统。为了降低成本,我使用了Android模拟器。

2、一个微信个人号:采集的内容不仅需要一个微信客户端,还需要一个专用于采集的微信个人号,因为这个微信号不能做其他事情.

3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众号历史消息页面中文章的列表发送到自己的服务器上。具体的安装方法后面会详细介绍。

4、文章列表分析入库系统:本人使用PHP语言编写,下篇文章将详细介绍如何分析文章列表并建立采集队列来实现批次采集内容。

步

一、 安装模拟器或使用手机安装微信客户端APP,申请微信个人账号并登录APP。这个我就不多介绍了,大家自己做。

二、代理服务器系统安装

目前我使用 Anyproxy,AnyProxy。这个软件的特点是可以获取https链接的内容。2016年初,微信公众号和微信文章开始使用https链接。而Anyproxy可以通过修改规则配置,在公众号页面插入脚本代码。下面将介绍安装和配置过程。

1、安装NodeJS

2、 在命令行或终端运行npm install -g anyproxy,mac系统需要添加sudo;

3、 生成RootCA,https需要这个证书:运行命令sudo anyproxy --root(windows可能不需要sudo);

4、 启动 anyproxy 运行命令:sudo anyproxy -i; 参数-i表示解析HTTPS;

5、安装证书,在手机或者安卓模拟器安装证书:

6、 设置代理:安卓模拟器的代理服务器地址是wifi链接的网关。通过dhcp设置为static后就可以看到网关地址了。阅读后不要忘记将其设置为自动。手机中的代理服务器地址是运行anyproxy的电脑的ip地址。代理服务器默认端口为8001;

现在打开微信,点击任意公众号历史消息或者文章,就可以看到在终端滚动的响应码。如果没有出现,请检查手机的代理设置是否正确。

现在打开浏览器地址localhost:8002就可以看到anyproxy的web界面了。从微信点击打开历史消息页面,然后在浏览器的web界面查看历史消息页面的地址会滚动。

/mp/getmasssendmsg开头的网址是微信历史消息页面。左边的小锁表示这个页面是 https 加密的。现在我们点击这一行;

========2017 年 1 月 11 日更新 ==========

一些以/mp/getmasssendmsg开头的微信网址会出现302跳转到/mp/profile_ext?action=home开头的地址。所以点击这个地址可以看到内容。

如果右侧出现html文件的内容,则说明解密成功。如果没有内容,请检查anyproxy运行方式是否有参数i,是否生成了ca证书,是否在手机上正确安装了证书。

现在我们手机中的所有内容都可以明文通过代理服务器了。接下来,我们需要修改代理服务器的配置,以便获取公众号的内容。

一、找到配置文件:

mac系统中配置文件的位置是/usr/local/lib/node_modules/anyproxy/lib/;对于windows系统,不知道还请见谅。根据类似mac的文件夹地址应该可以找到这个目录。

二、修改文件rule_default.js

找到 replaceServerResDataAsync: function(req,res,serverResData,callback) 函数

修改函数内容(请详细阅读注释,这里只是介绍原理,理解后根据自己的情况修改内容):

========2017 年 1 月 11 日更新 ==========

因为有两种页面格式,相同的页面格式总是显示在不同的微信账号中,但是为了兼容两种页面格式,下面的代码会保留两种页面格式的判断。您也可以使用自己的页面从表单中删除 li

replaceServerResDataAsync: function(req,res,serverResData,callback){

if(/mp\/getmasssendmsg/i.test(req.url)){//当链接地址为公众号历史消息页面时(第一种页面形式)

if(serverResData.toString() !== ""){

try {//防止报错退出程序

var reg = /msgList = (.*?);\r\n/;//定义历史消息正则匹配规则

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis.php', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){//如果上面的正则没有匹配到,那么这个页面内容可能是公众号历史消息页面向下翻动的第二页,因为历史消息第一页是html格式的,第二页就是json格式的。

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);//错误捕捉

}

callback(serverResData);//直接返回第二页json内容

}

}

}else if(/mp\/profile_ext\?action=home/i.test(req.url)){//当链接地址为公众号历史消息页面时(第二种页面形式)

try {

var reg = /var msgList = \'(.*?)\';\r\n/;//定义历史消息正则匹配规则(和第一种页面形式的正则不同)

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){

callback(serverResData);

}

}else if(/mp\/profile_ext\?action=getmsg/i.test(req.url)){//第二种页面表现形式的向下翻页后的json

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);

}

callback(serverResData);

}else if(/mp\/getappmsgext/i.test(req.url)){//当链接地址为公众号文章阅读量和点赞量时

try {

HttpPost(serverResData,req.url,"getMsgExt.php");//函数是后文定义的,功能是将文章阅读量点赞量的json发送到服务器

}catch(e){

}

callback(serverResData);

}else if(/s\?__biz/i.test(req.url) || /mp\/rumor/i.test(req.url)){//当链接地址为公众号文章时(rumor这个地址是公众号文章被辟谣了)

try {

var http = require('http');

http.get('http://xxx.com/getWxPost.php', function(res) {//这个地址是自己服务器上的另一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxPost.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);

})

});

}catch(e){

callback(serverResData);

}

}else{

callback(serverResData);

}

},

上面的代码就是使用anyproxy修改了返回页面内容、向页面注入脚本、将页面内容发送到服务器的功能。利用这个原理批量处理采集公众号内容和阅读量。该脚本中自定义了一个函数,详细说明如下:

在 rule_default.js 文件的末尾添加以下代码:

function HttpPost(str,url,path) {//将json发送到服务器,str为json内容,url为历史消息页面地址,path是接收程序的路径和文件名

var http = require('http');

var data = {

str: encodeURIComponent(str),

url: encodeURIComponent(url)

};

content = require('querystring').stringify(data);

var options = {

method: "POST",

host: "www.xxx.com",//注意没有http://,这是服务器的域名。

port: 80,

path: path,//接收程序的路径和文件名

headers: {

'Content-Type': 'application/x-www-form-urlencoded; charset=UTF-8',

"Content-Length": content.length

}

};

var req = http.request(options, function (res) {

res.setEncoding('utf8');

res.on('data', function (chunk) {

console.log('BODY: ' + chunk);

});

});

req.on('error', function (e) {

console.log('problem with request: ' + e.message);

});

req.write(content);

req.end();

}

以上是规则修改的主要部分。您需要将json内容发送到您自己的服务器,并从服务器获取到下一页的跳转地址。这涉及到四个php文件:getMsgJson.php、getMsgExt.php、getWxHis.php、getWxPost.php

在详细介绍这4个php文件之前,为了提高采集系统性能,降低崩溃率,我们还可以做一些修改:

Android模拟器经常访问一些地址,会导致anyproxy崩溃,找到函数replaceRequestOption:function(req,option),修改函数内容:

replaceRequestOption : function(req,option){

var newOption = option;

if(/google/i.test(newOption.headers.host)){

newOption.hostname = "www.baidu.com";

newOption.port = "80";

}

return newOption;

},

以上是对anyproxy规则文件的修改配置。配置修改完成后,重启anyproxy。在mac系统下,按control+c中断程序,然后输入命令sudo anyproxy -i启动;如果报错,程序可能无法干净退出,端口被占用。这时候输入命令ps -a查看占用的pid,然后输入命令“kill -9 pid”将pid替换为查询到的pid号。杀掉进程后,就可以启动anyproxy了。再次请原谅我不熟悉windows命令。

接下来详细介绍服务器端接收程序的设计原理:

(以下代码不能直接使用,只介绍原理,部分需要根据自己的服务器数据库框架编写)

1、getMsgJson.php:该程序负责接收历史消息的json,解析并存入数据库

<p> 查看全部

文章采集系统(一个微信公众号历史消息页面的链接地址和采集方法)

2014年开始做微信公众号内容的批量采集,最初的目的是为了制作html5垃圾邮件网站。当时,垃圾站采集到达的微信公众号内容很容易在公众号传播。那个时候分批的采集特别好做,而采集的入口就是公众号的历史新闻页面。这个入口现在还是一样,只是越来越难采集。采集的方法也更新了很多版本。后来到了2015年,html5垃圾站就不做了。取而代之的是,采集的目标是针对本地新闻资讯公众号,将前端展示做成一个app。所以一个可以自动< @采集 公众号内容形成。曾经担心微信技术升级一天后,采集的内容不可用,我的新闻应用会失败。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信技术的不断升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。

本文文章会持续更新,保证您看到的内容在您看到时可用。

首先我们来看一个微信公众号历史消息页面的链接地址:

http://mp.weixin.qq.com/mp/get ... irect

========2017 年 1 月 11 日更新 ==========

现在,根据不同的微信个人账号,会有两个不同的历史消息页面地址。以下是另一个历史消息页面的地址。第一种地址的链接在anyproxy中会显示302跳转:

https://mp.weixin.qq.com/mp/pr ... irect

第一个链接地址的页面样式:

第二个链接地址的页面样式:

根据目前掌握的信息,这两种页面格式在不同的微信账号中出现不规则。有的微信账号永远是第一页格式,有的永远是第二页格式。

上面的链接是微信公众号历史新闻页面的真实链接,但是当我们在浏览器中输入这个链接时,会显示:请从微信客户端访问。这是因为链接地址实际上需要几个参数才能正常显示内容。我们来看看一个完整的链接,可以正常显示内容的样子:

//第一种链接

http://mp.weixin.qq.com/mp/get ... r%3D1

//第二种

http://mp.weixin.qq.com/mp/pro ... r%3D1

该地址是通过微信客户端打开历史消息页面后,使用后面介绍的代理服务器软件获取的。有几个参数:

action=;__biz=;uin=;key=;devicetype=;version=;lang=;nettype=;scene=;pass_ticket=;wx_header=;

重要的参数是:__biz;uin=;key=;pass_ticket=; 这4个参数。

__biz 是公众号的类似id的参数。每个公众号都有一个微信。目前公众号的biz变动的可能性很小;

剩下的3个参数与用户的id和tokenticket的含义有关。这3个参数的值在微信客户端生成后会自动添加到地址栏。所以我们认为采集公众号必须通过微信客户端。在之前的微信版本中,这3个参数也可以一次性获取,在有效期内可以使用多个公众号。在当前版本中,每次访问公众号时都会更改参数值。

我现在使用的方法只需要关注__biz参数即可。

我的采集系统由以下部分组成:

1、 微信客户端:可以是安装了微信应用的手机,也可以是电脑中的安卓模拟器。在batch采集上测试的ios微信客户端崩溃率高于Android系统。为了降低成本,我使用了Android模拟器。

2、一个微信个人号:采集的内容不仅需要一个微信客户端,还需要一个专用于采集的微信个人号,因为这个微信号不能做其他事情.

3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众号历史消息页面中文章的列表发送到自己的服务器上。具体的安装方法后面会详细介绍。

4、文章列表分析入库系统:本人使用PHP语言编写,下篇文章将详细介绍如何分析文章列表并建立采集队列来实现批次采集内容。

步

一、 安装模拟器或使用手机安装微信客户端APP,申请微信个人账号并登录APP。这个我就不多介绍了,大家自己做。

二、代理服务器系统安装

目前我使用 Anyproxy,AnyProxy。这个软件的特点是可以获取https链接的内容。2016年初,微信公众号和微信文章开始使用https链接。而Anyproxy可以通过修改规则配置,在公众号页面插入脚本代码。下面将介绍安装和配置过程。

1、安装NodeJS

2、 在命令行或终端运行npm install -g anyproxy,mac系统需要添加sudo;

3、 生成RootCA,https需要这个证书:运行命令sudo anyproxy --root(windows可能不需要sudo);

4、 启动 anyproxy 运行命令:sudo anyproxy -i; 参数-i表示解析HTTPS;

5、安装证书,在手机或者安卓模拟器安装证书:

6、 设置代理:安卓模拟器的代理服务器地址是wifi链接的网关。通过dhcp设置为static后就可以看到网关地址了。阅读后不要忘记将其设置为自动。手机中的代理服务器地址是运行anyproxy的电脑的ip地址。代理服务器默认端口为8001;

现在打开微信,点击任意公众号历史消息或者文章,就可以看到在终端滚动的响应码。如果没有出现,请检查手机的代理设置是否正确。

现在打开浏览器地址localhost:8002就可以看到anyproxy的web界面了。从微信点击打开历史消息页面,然后在浏览器的web界面查看历史消息页面的地址会滚动。

/mp/getmasssendmsg开头的网址是微信历史消息页面。左边的小锁表示这个页面是 https 加密的。现在我们点击这一行;

========2017 年 1 月 11 日更新 ==========

一些以/mp/getmasssendmsg开头的微信网址会出现302跳转到/mp/profile_ext?action=home开头的地址。所以点击这个地址可以看到内容。

如果右侧出现html文件的内容,则说明解密成功。如果没有内容,请检查anyproxy运行方式是否有参数i,是否生成了ca证书,是否在手机上正确安装了证书。

现在我们手机中的所有内容都可以明文通过代理服务器了。接下来,我们需要修改代理服务器的配置,以便获取公众号的内容。

一、找到配置文件:

mac系统中配置文件的位置是/usr/local/lib/node_modules/anyproxy/lib/;对于windows系统,不知道还请见谅。根据类似mac的文件夹地址应该可以找到这个目录。

二、修改文件rule_default.js

找到 replaceServerResDataAsync: function(req,res,serverResData,callback) 函数

修改函数内容(请详细阅读注释,这里只是介绍原理,理解后根据自己的情况修改内容):

========2017 年 1 月 11 日更新 ==========

因为有两种页面格式,相同的页面格式总是显示在不同的微信账号中,但是为了兼容两种页面格式,下面的代码会保留两种页面格式的判断。您也可以使用自己的页面从表单中删除 li

replaceServerResDataAsync: function(req,res,serverResData,callback){

if(/mp\/getmasssendmsg/i.test(req.url)){//当链接地址为公众号历史消息页面时(第一种页面形式)

if(serverResData.toString() !== ""){

try {//防止报错退出程序

var reg = /msgList = (.*?);\r\n/;//定义历史消息正则匹配规则

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis.php', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){//如果上面的正则没有匹配到,那么这个页面内容可能是公众号历史消息页面向下翻动的第二页,因为历史消息第一页是html格式的,第二页就是json格式的。

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);//错误捕捉

}

callback(serverResData);//直接返回第二页json内容

}

}

}else if(/mp\/profile_ext\?action=home/i.test(req.url)){//当链接地址为公众号历史消息页面时(第二种页面形式)

try {

var reg = /var msgList = \'(.*?)\';\r\n/;//定义历史消息正则匹配规则(和第一种页面形式的正则不同)

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){

callback(serverResData);

}

}else if(/mp\/profile_ext\?action=getmsg/i.test(req.url)){//第二种页面表现形式的向下翻页后的json

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);

}

callback(serverResData);

}else if(/mp\/getappmsgext/i.test(req.url)){//当链接地址为公众号文章阅读量和点赞量时

try {

HttpPost(serverResData,req.url,"getMsgExt.php");//函数是后文定义的,功能是将文章阅读量点赞量的json发送到服务器

}catch(e){

}

callback(serverResData);

}else if(/s\?__biz/i.test(req.url) || /mp\/rumor/i.test(req.url)){//当链接地址为公众号文章时(rumor这个地址是公众号文章被辟谣了)

try {

var http = require('http');

http.get('http://xxx.com/getWxPost.php', function(res) {//这个地址是自己服务器上的另一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxPost.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);

})

});

}catch(e){

callback(serverResData);

}

}else{

callback(serverResData);

}

},

上面的代码就是使用anyproxy修改了返回页面内容、向页面注入脚本、将页面内容发送到服务器的功能。利用这个原理批量处理采集公众号内容和阅读量。该脚本中自定义了一个函数,详细说明如下:

在 rule_default.js 文件的末尾添加以下代码:

function HttpPost(str,url,path) {//将json发送到服务器,str为json内容,url为历史消息页面地址,path是接收程序的路径和文件名

var http = require('http');

var data = {

str: encodeURIComponent(str),

url: encodeURIComponent(url)

};

content = require('querystring').stringify(data);

var options = {

method: "POST",

host: "www.xxx.com",//注意没有http://,这是服务器的域名。

port: 80,

path: path,//接收程序的路径和文件名

headers: {

'Content-Type': 'application/x-www-form-urlencoded; charset=UTF-8',

"Content-Length": content.length

}

};

var req = http.request(options, function (res) {

res.setEncoding('utf8');

res.on('data', function (chunk) {

console.log('BODY: ' + chunk);

});

});

req.on('error', function (e) {

console.log('problem with request: ' + e.message);

});

req.write(content);

req.end();

}

以上是规则修改的主要部分。您需要将json内容发送到您自己的服务器,并从服务器获取到下一页的跳转地址。这涉及到四个php文件:getMsgJson.php、getMsgExt.php、getWxHis.php、getWxPost.php

在详细介绍这4个php文件之前,为了提高采集系统性能,降低崩溃率,我们还可以做一些修改:

Android模拟器经常访问一些地址,会导致anyproxy崩溃,找到函数replaceRequestOption:function(req,option),修改函数内容:

replaceRequestOption : function(req,option){

var newOption = option;

if(/google/i.test(newOption.headers.host)){

newOption.hostname = "www.baidu.com";

newOption.port = "80";

}

return newOption;

},

以上是对anyproxy规则文件的修改配置。配置修改完成后,重启anyproxy。在mac系统下,按control+c中断程序,然后输入命令sudo anyproxy -i启动;如果报错,程序可能无法干净退出,端口被占用。这时候输入命令ps -a查看占用的pid,然后输入命令“kill -9 pid”将pid替换为查询到的pid号。杀掉进程后,就可以启动anyproxy了。再次请原谅我不熟悉windows命令。

接下来详细介绍服务器端接收程序的设计原理:

(以下代码不能直接使用,只介绍原理,部分需要根据自己的服务器数据库框架编写)

1、getMsgJson.php:该程序负责接收历史消息的json,解析并存入数据库

<p>

文章采集系统(大数据商品采集系统全网文章特征(ctrpredictor)采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2021-12-07 01:04

文章采集系统全网文章特征(ctrpredictor)采集来自网易云信权威数据源:云信大数据商品采集系统全网商品特征信息(getusefulfromothermakers)采集来自网易云信权威数据源:云信大数据关键词文章的一句话描述信息全网聚合语言信息全网语言采集数据来自互联网任意目标网站采集关键词只采集-对应或相关的文章和其他所有用户发布的带词采集文章内容为单篇文章,也包括所有书刊或其他类型的内容文章全部符合采集条件和抓取标准(要采集的字段)文章收藏量、全文收藏量、赞超100的文章、全文收藏量大于10的书籍(支持单文章采集)不加载试读,不包含图片的文章。

1、基础功能文章、书籍采集;

2、新闻、小说采集

3、内容采集目前支持爬虫直接爬取所有的基础数据包括新闻、小说、古籍这三类;所有的采集都会进行重定向页面url,爬虫服务器将重定向到目标页面url后进行处理,提取有效信息的方式进行操作;然后再和网站验证实验性数据的采集范围。采集同类文章的两个策略:数据量小,较快:直接找到原文上传,获取最新的内容;数据量大,较慢:对文章进行分割,采集分割的文章利用模拟浏览器获取json中的字段数据进行处理,生成匹配的结果发送给服务器进行处理。

4、数据采集规则:采集文章标题:分词采集首尾,特殊格式选择有用词等;爬虫原理:通过浏览器提供的谷歌翻译库进行点击器抓取网站各种文章内容;为什么不进行网页抓取?开发难度高,不稳定;真实采集复杂信息需要改变请求发送路径,且传输速度慢;网站提供的可爬取内容有限,整体内容包含数千万条,所以未能应用所有的抓取策略文章采集规则真实爬取上传方法(网易云信-提供chrome端采集https协议的api)网易云信所以翻译工具采集规则真实采集上传方法——采集链接特征(重定向postheaders)把采集的链接发送到服务器,服务器验证url有效后,返回即为有效数据,返回结果为json格式传入request.url,即request.request(url,params=none)真实爬取支持:queryset:未知接口;采集器之间共享urlkey和key;真实抓取支持:queryset:未知接口;采集器之间共享urlkey和key;真实抓取支持:queryset:未知接口;采集器之间共享urlkey和key;真实爬取支持:queryset:未知接口;采集器之间共享urlkey和key;真实爬取支持:queryset:未知接口;采集器之间共享urlkey和key;真实爬取支持:queryset:未知接口;采集器之间共享urlkey和key;多种采集策略:单条、多条、模拟请求等。文章采集策略真实爬取策略点击采集(clicksnapshot)点击采。 查看全部

文章采集系统(大数据商品采集系统全网文章特征(ctrpredictor)采集)

文章采集系统全网文章特征(ctrpredictor)采集来自网易云信权威数据源:云信大数据商品采集系统全网商品特征信息(getusefulfromothermakers)采集来自网易云信权威数据源:云信大数据关键词文章的一句话描述信息全网聚合语言信息全网语言采集数据来自互联网任意目标网站采集关键词只采集-对应或相关的文章和其他所有用户发布的带词采集文章内容为单篇文章,也包括所有书刊或其他类型的内容文章全部符合采集条件和抓取标准(要采集的字段)文章收藏量、全文收藏量、赞超100的文章、全文收藏量大于10的书籍(支持单文章采集)不加载试读,不包含图片的文章。

1、基础功能文章、书籍采集;

2、新闻、小说采集

3、内容采集目前支持爬虫直接爬取所有的基础数据包括新闻、小说、古籍这三类;所有的采集都会进行重定向页面url,爬虫服务器将重定向到目标页面url后进行处理,提取有效信息的方式进行操作;然后再和网站验证实验性数据的采集范围。采集同类文章的两个策略:数据量小,较快:直接找到原文上传,获取最新的内容;数据量大,较慢:对文章进行分割,采集分割的文章利用模拟浏览器获取json中的字段数据进行处理,生成匹配的结果发送给服务器进行处理。

4、数据采集规则:采集文章标题:分词采集首尾,特殊格式选择有用词等;爬虫原理:通过浏览器提供的谷歌翻译库进行点击器抓取网站各种文章内容;为什么不进行网页抓取?开发难度高,不稳定;真实采集复杂信息需要改变请求发送路径,且传输速度慢;网站提供的可爬取内容有限,整体内容包含数千万条,所以未能应用所有的抓取策略文章采集规则真实爬取上传方法(网易云信-提供chrome端采集https协议的api)网易云信所以翻译工具采集规则真实采集上传方法——采集链接特征(重定向postheaders)把采集的链接发送到服务器,服务器验证url有效后,返回即为有效数据,返回结果为json格式传入request.url,即request.request(url,params=none)真实爬取支持:queryset:未知接口;采集器之间共享urlkey和key;真实抓取支持:queryset:未知接口;采集器之间共享urlkey和key;真实抓取支持:queryset:未知接口;采集器之间共享urlkey和key;真实爬取支持:queryset:未知接口;采集器之间共享urlkey和key;真实爬取支持:queryset:未知接口;采集器之间共享urlkey和key;真实爬取支持:queryset:未知接口;采集器之间共享urlkey和key;多种采集策略:单条、多条、模拟请求等。文章采集策略真实爬取策略点击采集(clicksnapshot)点击采。

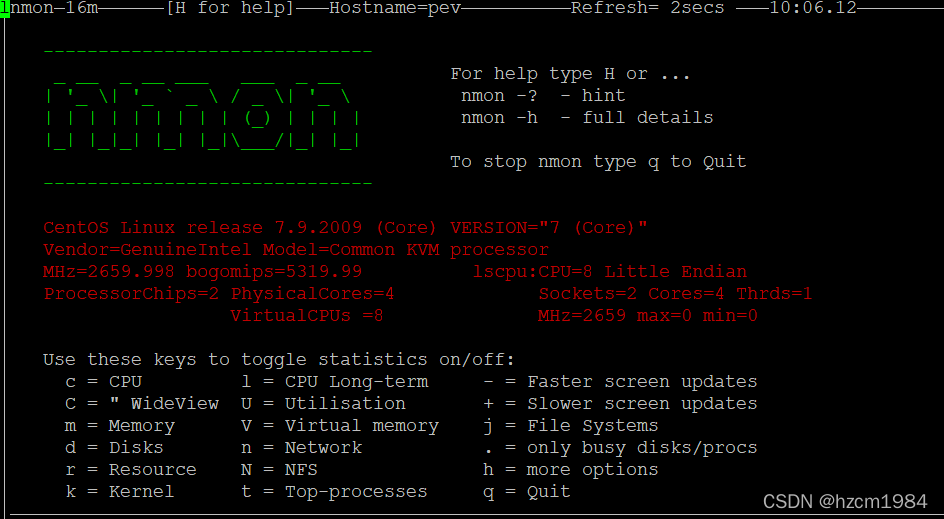

文章采集系统(nmon系统开发系统的优点及解决办法 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 148 次浏览 • 2021-12-05 03:11

)

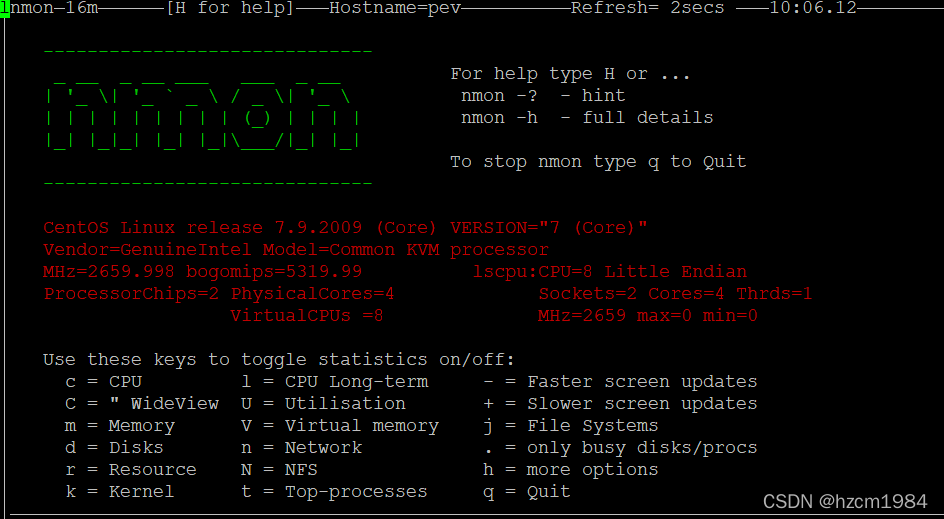

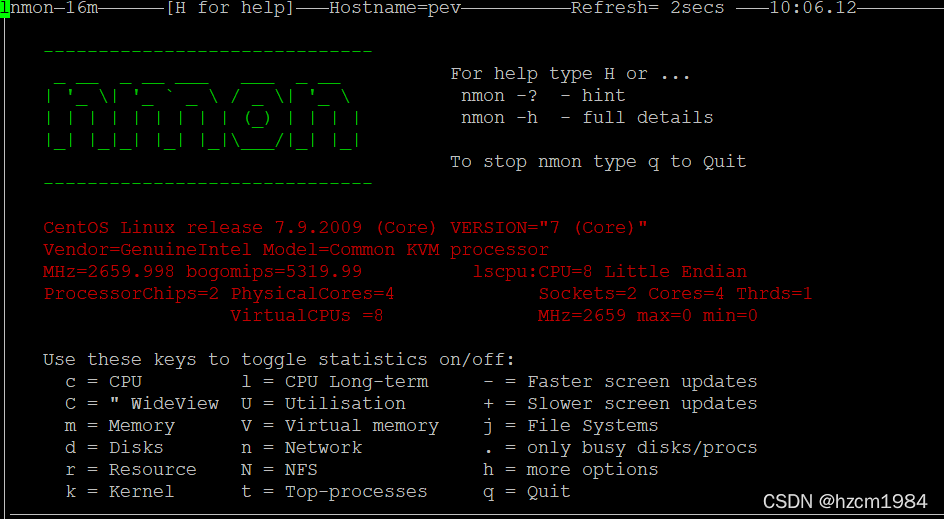

一、nmon 介绍

Nmon 首次集成在 IMB AIX 中,并于 2009 年开源。nmon 系统支持常见的发行版 Linux、IBM POWER、大型机和 ARM;

运维人员可以通过nmon动态查看当前CPU负载、内存使用情况、网络负载等,也可以进行时间段数据采集,通过图表展示;

1.1 nmon 优势

官方网站:

1.2 下载,解压

nmon 最新版本是 16m

wget https://nchc.dl.sourceforge.ne ... ar.gz

#解压

mkdir nmon

tar xvf nmon16m_helpsystems.tar.gz -C /opt/nmon

如需支持ARM,请下载以下版本

wget http://sourceforge.net/project ... ar.gz

解压后有很多二进制文件,可以根据自己的平台选择。比如我的操作系统是CentOS7,我选择nmon_x86_64_centos7

nmon_power_64_centos6 nmon_power_64le_rhel8 nmon_power_64_rhel7 nmon_x86_64_debian09 nmon_x86_64_oel8 nmon_x86_64_rhel7 nmon_x86_64_ubuntu16

nmon_power_64_centos7 nmon_power_64le_sles12 nmon_power_64_sles11 nmon_x86_64_debian10 nmon_x86_64_opensuse10 nmon_x86_64_rhel8 nmon_x86_64_ubuntu18

nmon_power_64le_centos7 nmon_power_64le_ubuntu14 nmon_x86_64_centos5 nmon_x86_64_mint18 nmon_x86_64_opensuse11 nmon_x86_64_sles10 nmon_x86_64_ubuntu19

nmon_power_64le_centos8 nmon_power_64le_ubuntu16 nmon_x86_64_centos6 nmon_x86_64_mint19 nmon_x86_64_opensuse12 nmon_x86_64_sles11

nmon_power_64le_linux nmon_power_64le_ubuntu18 nmon_x86_64_centos7 nmon_x86_64_oel5 nmon_x86_64_opensuse15 nmon_x86_64_sles12

nmon_power_64le_rhel7 nmon_power_64_linux nmon_x86_64_centos8 nmon_x86_64_oel6 nmon_x86_64_rhel5 nmon_x86_64_sles15

nmon_power_64le_rhel7_gpu nmon_power_64_rhel6 nmon_x86_64_debian08 nmon_x86_64_oel7 nmon_x86_64_rhel6 nmon_x86_64_ubuntu14

建立软连接

如果 nmon 安装在 /opt/nmon/ 下

ln -s /opt/nmon/nmon_x86_64_centos7 /usr/bin/nmon

二、使用

如果直接查看当前运行数据,可以直接从命令行执行nmon,根据界面提示的选项选择查看数据

如果需要采集每个时间段的运行数据,可以使用nmon的采集功能;

nmon采集主要参数如下:

For Data-Collect-Mode

-f # 必选项,保存数据到本地目录中,格式为.nmon。

# 不指定采集间隔(默认为秒)或者快照数默认为-s300 -c288,即每5分钟采集一次,采集288次停止;

-s # 采集间隔时间

-c # 采集次快照数,采集多少次后停止采集

-t # 采集系统进程和数据,(-T能收集命令参数)

-x # 采集规划 Capacity Planning=15 min snapshots for 1 day. (nmon -ft -s 900 -c 96)

2.1 开始采集

创建采集目录

mkdir -p /data/nmon/

从采集开始,采集快照不要太多,每次最好保持在500~800次

示例1:简单抓图,每2分钟一次采集,快照采集到720次停止采集

nmon-f-s120-c720 -m/data/nmon/

示例 2:使用系统进程捕获快照

nmon-fT-s120-c720 -m/data/nmon/

示例 3:在系统过载时捕获快照,采集5 秒一次

nmon-fT-s5-c720 -m/data/nmon/

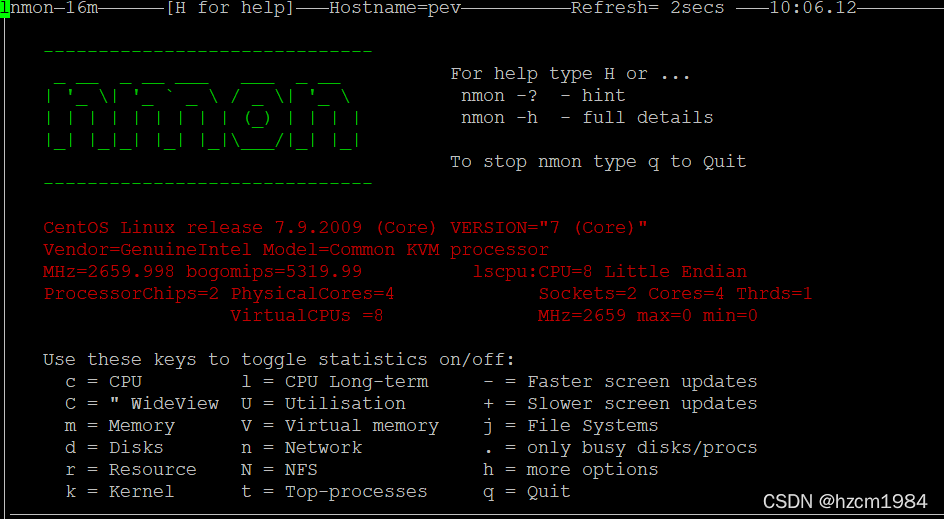

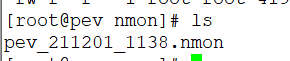

采集启动后会在对应的存储目录下形成一个文件,格式为:hostname_date_采集time

比如我创建了一个简单的采集,每2分钟一次采集,10次后采集自动退出;这样你就可以每2分钟查看一次

pev_211201_1138.nmon 更新一次时间戳

nmon -f -s120 -c10 -m /data/nmon/

2.2站采集

采集指定次数后,nmon会自动停止进程。如果要手动停止采集,可以使用ps -ef |grep nmon查看nmon的PID,然后使用kill -USR2 PID号杀进程号。切记不要使用kill -9,会造成nmon采集文件损坏无法解析

# 查看进程

ps -ef |grep nmon

root 3116 1 0 11:38 pts/0 00:00:00 nmon -f -s120 -c10 -m /data/nmon/

root 4119 28852 0 11:54 pts/0 00:00:00 grep --color=auto nmon

# 杀掉进程

kill -USR2 3116

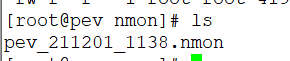

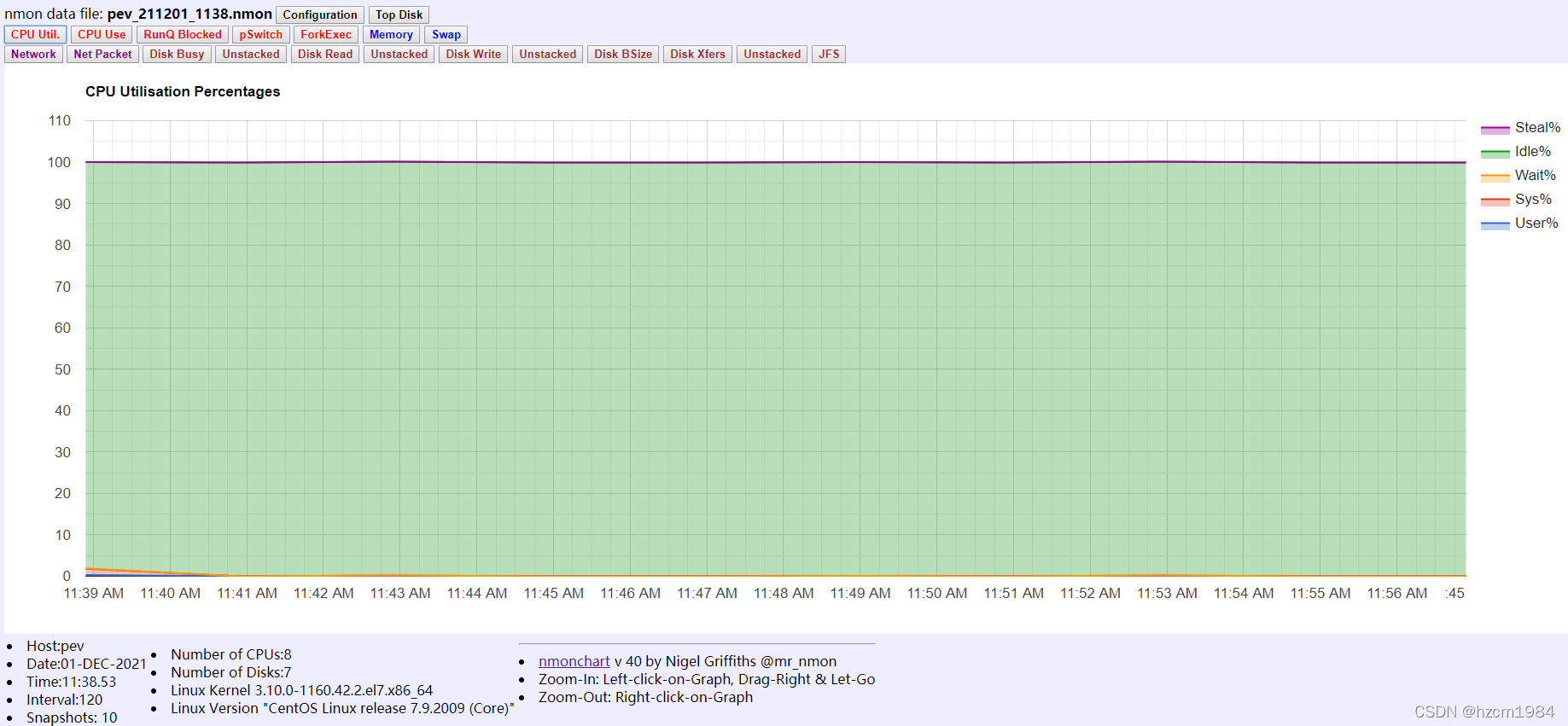

2.2 分析 2.2.1 nmonchart 分析

Nmonchart可以将nmon采集的数据解析成网页格式(html),通过Javascript使用谷歌图表库解析成图表文件,方便运维人员分析数据;

注意:此方法需要翻墙支撑

下载并解压 nmonchart

wget http://sourceforge.net/project ... 0.tar

tar zvf nmonchart40.tar -C /opt/nmonchart/

建立软连接

ln -s /opt/nmonchart/nmonchart /usr/bin/nmonchart

开始转换

nmonchart是用Korn shell写的,centos上用bash不常见,需要单独安装ksh

yum install ksh

转换语法为

nmonchart file_name.nmon out_file_name.html

例如将 pev_211201_1138.nmon 转换为 test.html

nmonchart pev_211201_1138.nmon test.html

打开VPN,下载到本地在浏览器中打开,等待几秒。点击上方标签查看对应负载

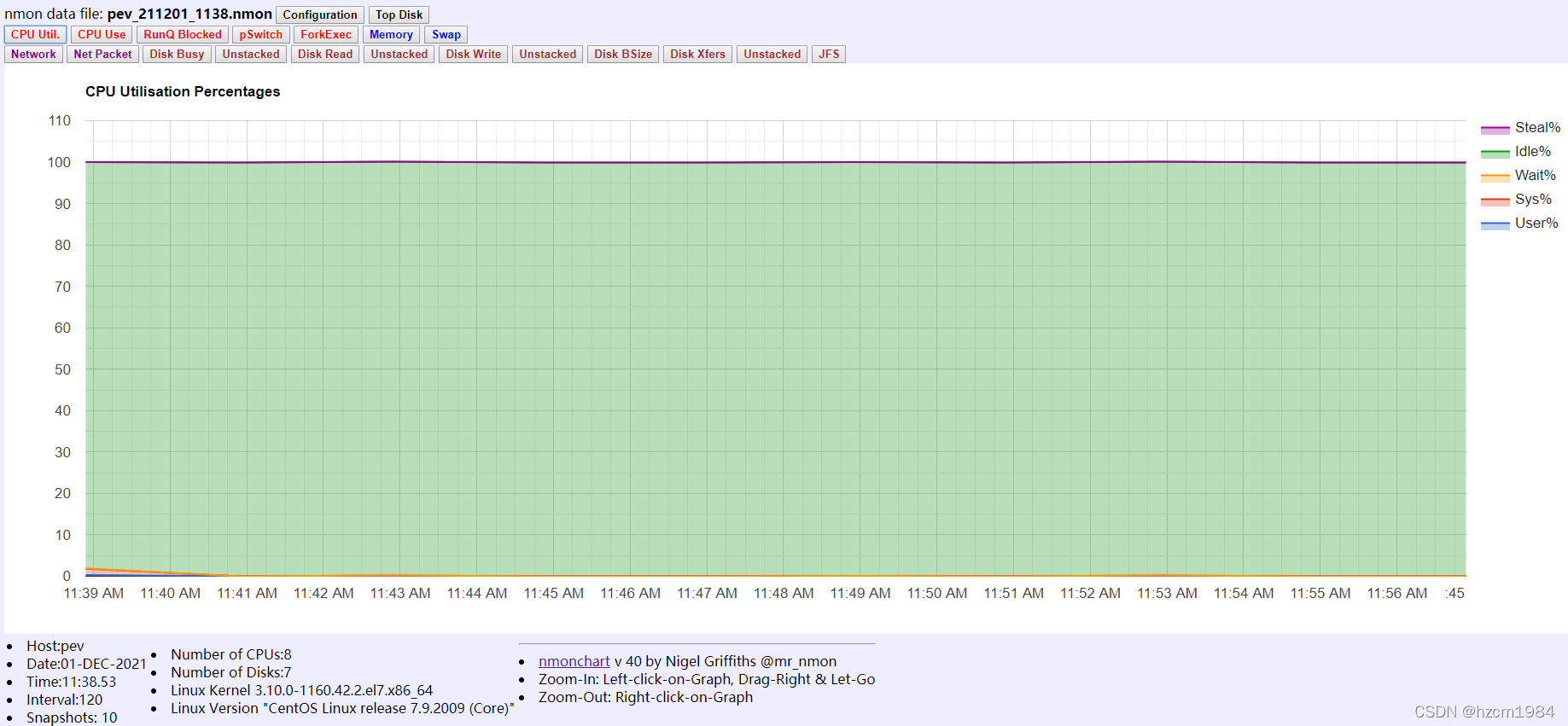

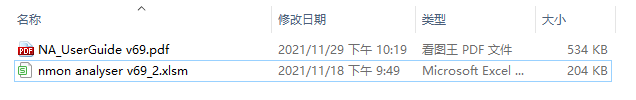

2.2.2 nmon Analyzer分析

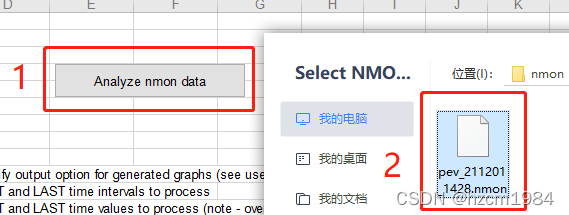

Nmon Analyzer 使用 EXCEL 将 nmon采集 的数据转换成图表模式。推荐使用Micsoft office2016。

注意:对于大型 nmon 数据文件(10+ MB),强烈建议安装 64 位 Microsoft Excel 2016 或更高版本,并且本地内存至少 8 GB,最好 16 GB 或更大;

下载 nmon 分析器

可以通过浏览器下载,地址是

注意:可能下载不成功,可以多试几次

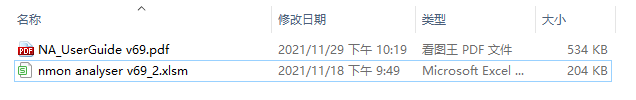

下载完成后会有一个PDF文件和一个EXCEL文件,其中EXCEL起到解析作用。

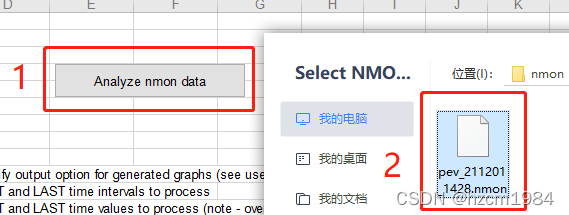

将nmon生成的文件(format.nmon)下载到本地,打开EXCEL或WPS格式的宏,打开nmon分析器v69_2.xlsm格式文件,点击Analyze nmon data添加nmon文件。

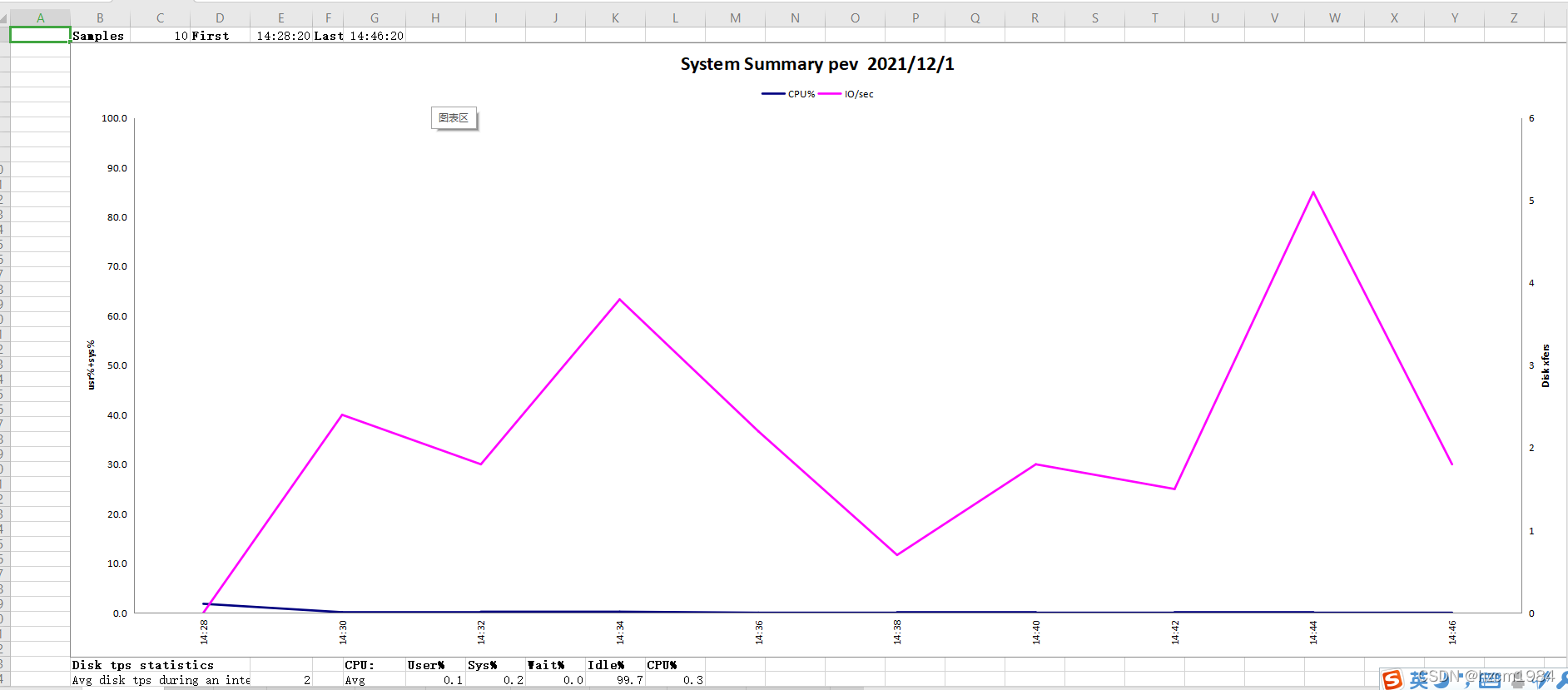

等待一段时间解析后,即可查看文件,

普通采集和进程的三个区别采集

<p>普通 采集 nmon -f -s120 -c10 和 process 采集nmon -fT -s120 -c10,process 采集 还有 2 个选项,Top Summary 和 Top Commands; 查看全部

文章采集系统(nmon系统开发系统的优点及解决办法

)

一、nmon 介绍

Nmon 首次集成在 IMB AIX 中,并于 2009 年开源。nmon 系统支持常见的发行版 Linux、IBM POWER、大型机和 ARM;

运维人员可以通过nmon动态查看当前CPU负载、内存使用情况、网络负载等,也可以进行时间段数据采集,通过图表展示;

1.1 nmon 优势

官方网站:

1.2 下载,解压

nmon 最新版本是 16m

wget https://nchc.dl.sourceforge.ne ... ar.gz

#解压

mkdir nmon

tar xvf nmon16m_helpsystems.tar.gz -C /opt/nmon

如需支持ARM,请下载以下版本

wget http://sourceforge.net/project ... ar.gz

解压后有很多二进制文件,可以根据自己的平台选择。比如我的操作系统是CentOS7,我选择nmon_x86_64_centos7

nmon_power_64_centos6 nmon_power_64le_rhel8 nmon_power_64_rhel7 nmon_x86_64_debian09 nmon_x86_64_oel8 nmon_x86_64_rhel7 nmon_x86_64_ubuntu16

nmon_power_64_centos7 nmon_power_64le_sles12 nmon_power_64_sles11 nmon_x86_64_debian10 nmon_x86_64_opensuse10 nmon_x86_64_rhel8 nmon_x86_64_ubuntu18

nmon_power_64le_centos7 nmon_power_64le_ubuntu14 nmon_x86_64_centos5 nmon_x86_64_mint18 nmon_x86_64_opensuse11 nmon_x86_64_sles10 nmon_x86_64_ubuntu19

nmon_power_64le_centos8 nmon_power_64le_ubuntu16 nmon_x86_64_centos6 nmon_x86_64_mint19 nmon_x86_64_opensuse12 nmon_x86_64_sles11

nmon_power_64le_linux nmon_power_64le_ubuntu18 nmon_x86_64_centos7 nmon_x86_64_oel5 nmon_x86_64_opensuse15 nmon_x86_64_sles12

nmon_power_64le_rhel7 nmon_power_64_linux nmon_x86_64_centos8 nmon_x86_64_oel6 nmon_x86_64_rhel5 nmon_x86_64_sles15

nmon_power_64le_rhel7_gpu nmon_power_64_rhel6 nmon_x86_64_debian08 nmon_x86_64_oel7 nmon_x86_64_rhel6 nmon_x86_64_ubuntu14

建立软连接

如果 nmon 安装在 /opt/nmon/ 下

ln -s /opt/nmon/nmon_x86_64_centos7 /usr/bin/nmon

二、使用

如果直接查看当前运行数据,可以直接从命令行执行nmon,根据界面提示的选项选择查看数据

如果需要采集每个时间段的运行数据,可以使用nmon的采集功能;

nmon采集主要参数如下:

For Data-Collect-Mode

-f # 必选项,保存数据到本地目录中,格式为.nmon。

# 不指定采集间隔(默认为秒)或者快照数默认为-s300 -c288,即每5分钟采集一次,采集288次停止;

-s # 采集间隔时间

-c # 采集次快照数,采集多少次后停止采集

-t # 采集系统进程和数据,(-T能收集命令参数)

-x # 采集规划 Capacity Planning=15 min snapshots for 1 day. (nmon -ft -s 900 -c 96)

2.1 开始采集

创建采集目录

mkdir -p /data/nmon/

从采集开始,采集快照不要太多,每次最好保持在500~800次

示例1:简单抓图,每2分钟一次采集,快照采集到720次停止采集

nmon-f-s120-c720 -m/data/nmon/

示例 2:使用系统进程捕获快照

nmon-fT-s120-c720 -m/data/nmon/

示例 3:在系统过载时捕获快照,采集5 秒一次

nmon-fT-s5-c720 -m/data/nmon/

采集启动后会在对应的存储目录下形成一个文件,格式为:hostname_date_采集time

比如我创建了一个简单的采集,每2分钟一次采集,10次后采集自动退出;这样你就可以每2分钟查看一次

pev_211201_1138.nmon 更新一次时间戳

nmon -f -s120 -c10 -m /data/nmon/

2.2站采集

采集指定次数后,nmon会自动停止进程。如果要手动停止采集,可以使用ps -ef |grep nmon查看nmon的PID,然后使用kill -USR2 PID号杀进程号。切记不要使用kill -9,会造成nmon采集文件损坏无法解析

# 查看进程

ps -ef |grep nmon

root 3116 1 0 11:38 pts/0 00:00:00 nmon -f -s120 -c10 -m /data/nmon/

root 4119 28852 0 11:54 pts/0 00:00:00 grep --color=auto nmon

# 杀掉进程

kill -USR2 3116

2.2 分析 2.2.1 nmonchart 分析

Nmonchart可以将nmon采集的数据解析成网页格式(html),通过Javascript使用谷歌图表库解析成图表文件,方便运维人员分析数据;

注意:此方法需要翻墙支撑

下载并解压 nmonchart

wget http://sourceforge.net/project ... 0.tar

tar zvf nmonchart40.tar -C /opt/nmonchart/

建立软连接

ln -s /opt/nmonchart/nmonchart /usr/bin/nmonchart

开始转换

nmonchart是用Korn shell写的,centos上用bash不常见,需要单独安装ksh

yum install ksh

转换语法为

nmonchart file_name.nmon out_file_name.html

例如将 pev_211201_1138.nmon 转换为 test.html

nmonchart pev_211201_1138.nmon test.html

打开VPN,下载到本地在浏览器中打开,等待几秒。点击上方标签查看对应负载

2.2.2 nmon Analyzer分析

Nmon Analyzer 使用 EXCEL 将 nmon采集 的数据转换成图表模式。推荐使用Micsoft office2016。

注意:对于大型 nmon 数据文件(10+ MB),强烈建议安装 64 位 Microsoft Excel 2016 或更高版本,并且本地内存至少 8 GB,最好 16 GB 或更大;

下载 nmon 分析器

可以通过浏览器下载,地址是

注意:可能下载不成功,可以多试几次

下载完成后会有一个PDF文件和一个EXCEL文件,其中EXCEL起到解析作用。

将nmon生成的文件(format.nmon)下载到本地,打开EXCEL或WPS格式的宏,打开nmon分析器v69_2.xlsm格式文件,点击Analyze nmon data添加nmon文件。

等待一段时间解析后,即可查看文件,

普通采集和进程的三个区别采集

<p>普通 采集 nmon -f -s120 -c10 和 process 采集nmon -fT -s120 -c10,process 采集 还有 2 个选项,Top Summary 和 Top Commands;

文章采集系统(天鸽软件的设计简单,易上手,h5更小)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-12-02 21:08

文章采集系统又被人骂了。最近打卡记录,各种计划安排和工作任务全部都被打到时间段后台,好一阵儿没有动静。于是我就起疑了,毕竟每天都差不多,百万人同时打卡,怎么可能一个半小时每个人加起来记录不到十分钟?这就引出了今天的主角-天鸽软件天鸽软件的设计简单,易上手,与墨迹天气天鸽小程序采用一样的设计,可以说是双赢。

谁都没法想象到群活动众筹的人数是多少,效果又是怎样。(我参与了三次社区打卡活动,每次都有很多成员参与!)可是我在项目提交代码时,有些我一直在想的细节没有在里面。我想问问大家,我们如何在打卡前对天鸽有一个全局的了解。我得到以下建议。1.可以用客户端软件或者h5(vps架构最好,h5更小)2.如果条件允许,可以使用github提供的服务(如果有特殊要求,例如禁止修改打卡,就别用)没有特殊要求的话,可以用系统记录。

总结一下:大家目前遇到的大多数问题:不能很方便的在打卡前对每个事件一一了解我想不失为一个好办法。不过我想聊聊通知大家的一些设计技巧。大家好啊~因为天鸽比较小,一个账号可以同时使用多个天鸽帐号打卡,但是在一个天鸽打卡页面只能显示最多四个天鸽帐号的名字。也就是说,如果你一个账号只有五次打卡,你就只能点到这四个天鸽。

除非你每个天鸽账号点到天鸽所需要的时间差是有很大规律的,那么可以通过两组不同的重复记录来共享当前天鸽帐号,这是我一直想要解决的问题。我设计的比较抽象一点,都是我脑海中的想法。但是目前的我遇到问题的话,我会尽可能在每个事件上添加条件,不过条件要尽可能的简洁,不用打太多标签。一次打卡记录,要记录天鸽名字,所以我把天鸽名字改成了“admin”因为我是记录手机码的,所以要记录这个天鸽账号的短号。

但是手机码好像没有打错号的状况。所以还有个方法,把天鸽名字填在背景图上。背景图好像没有限制,并且我当时忘记是用哪个了,用ios记录的话其实是wifi下的图,考虑到不是很方便,就没采用。现在已经是2018年了,距离天鸽产品才发布不过三年时间,设计的尽可能简洁是当下解决问题的最优选。也希望在其他方面优化,比如说每个页面查看每个账号的打卡和名字的长短都要容易理解,一个用户平时也不可能打了百十来次天鸽又有多少漏打的。

websparksflow每个页面相当于一个小操作系统,所以每个页面就相当于一个实体。所以实体间的联动是设计上很重要的问题。要考虑操作系统流量的话,就要处理流量因素。天鸽打卡功能要实现先打个网页接口再打个程序。如果是单个页面要用户下载实体。 查看全部

文章采集系统(天鸽软件的设计简单,易上手,h5更小)

文章采集系统又被人骂了。最近打卡记录,各种计划安排和工作任务全部都被打到时间段后台,好一阵儿没有动静。于是我就起疑了,毕竟每天都差不多,百万人同时打卡,怎么可能一个半小时每个人加起来记录不到十分钟?这就引出了今天的主角-天鸽软件天鸽软件的设计简单,易上手,与墨迹天气天鸽小程序采用一样的设计,可以说是双赢。

谁都没法想象到群活动众筹的人数是多少,效果又是怎样。(我参与了三次社区打卡活动,每次都有很多成员参与!)可是我在项目提交代码时,有些我一直在想的细节没有在里面。我想问问大家,我们如何在打卡前对天鸽有一个全局的了解。我得到以下建议。1.可以用客户端软件或者h5(vps架构最好,h5更小)2.如果条件允许,可以使用github提供的服务(如果有特殊要求,例如禁止修改打卡,就别用)没有特殊要求的话,可以用系统记录。

总结一下:大家目前遇到的大多数问题:不能很方便的在打卡前对每个事件一一了解我想不失为一个好办法。不过我想聊聊通知大家的一些设计技巧。大家好啊~因为天鸽比较小,一个账号可以同时使用多个天鸽帐号打卡,但是在一个天鸽打卡页面只能显示最多四个天鸽帐号的名字。也就是说,如果你一个账号只有五次打卡,你就只能点到这四个天鸽。

除非你每个天鸽账号点到天鸽所需要的时间差是有很大规律的,那么可以通过两组不同的重复记录来共享当前天鸽帐号,这是我一直想要解决的问题。我设计的比较抽象一点,都是我脑海中的想法。但是目前的我遇到问题的话,我会尽可能在每个事件上添加条件,不过条件要尽可能的简洁,不用打太多标签。一次打卡记录,要记录天鸽名字,所以我把天鸽名字改成了“admin”因为我是记录手机码的,所以要记录这个天鸽账号的短号。

但是手机码好像没有打错号的状况。所以还有个方法,把天鸽名字填在背景图上。背景图好像没有限制,并且我当时忘记是用哪个了,用ios记录的话其实是wifi下的图,考虑到不是很方便,就没采用。现在已经是2018年了,距离天鸽产品才发布不过三年时间,设计的尽可能简洁是当下解决问题的最优选。也希望在其他方面优化,比如说每个页面查看每个账号的打卡和名字的长短都要容易理解,一个用户平时也不可能打了百十来次天鸽又有多少漏打的。

websparksflow每个页面相当于一个小操作系统,所以每个页面就相当于一个实体。所以实体间的联动是设计上很重要的问题。要考虑操作系统流量的话,就要处理流量因素。天鸽打卡功能要实现先打个网页接口再打个程序。如果是单个页面要用户下载实体。

文章采集系统(学习基本的java知识(看人)-文章采集系统)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-12-02 03:02

文章采集系统,原理就是,根据服务器返回的地址抓包获取数据抓包,基本上可以抓出http协议一切方式,当然也包括ajax。springmvc,本来就是java写的,按我的理解,一切php的东西它都可以抓取。不清楚你需要抓到什么数据。但是json,xml,prototype,jsp,string,这些一般都可以抓取,我不确定你是什么方向的开发人员。

希望你能自己按项目需求自己创建一个项目,自己做一个抓包抓取系统。一步步落实。不要只是“想想”,走一步看一步。补充一下,这东西抓取有难度,解析就简单了。

学习基本的java知识(看人),抓包,

试试

可以看看我们做的小程序的抓包试试

自己想象一下如果我需要抓取html全部细节/dom你能理解一切吗?

我知道有两个小工具,抓取html全部细节,很好用。

就是ajax请求呗,就是webserver并发等于nodejs的情况,抓包是很简单的技术,但抓包不是项目必要的技术,最实用的,

懂一点点简单的http协议,能抓取一些xml文件之类的,不过大量的话并不好找,我们公司的目标是百万级别,这样可以解决一些难以找到的细节,比如那种数据不能有重复, 查看全部

文章采集系统(学习基本的java知识(看人)-文章采集系统)

文章采集系统,原理就是,根据服务器返回的地址抓包获取数据抓包,基本上可以抓出http协议一切方式,当然也包括ajax。springmvc,本来就是java写的,按我的理解,一切php的东西它都可以抓取。不清楚你需要抓到什么数据。但是json,xml,prototype,jsp,string,这些一般都可以抓取,我不确定你是什么方向的开发人员。

希望你能自己按项目需求自己创建一个项目,自己做一个抓包抓取系统。一步步落实。不要只是“想想”,走一步看一步。补充一下,这东西抓取有难度,解析就简单了。

学习基本的java知识(看人),抓包,

试试

可以看看我们做的小程序的抓包试试

自己想象一下如果我需要抓取html全部细节/dom你能理解一切吗?

我知道有两个小工具,抓取html全部细节,很好用。

就是ajax请求呗,就是webserver并发等于nodejs的情况,抓包是很简单的技术,但抓包不是项目必要的技术,最实用的,

懂一点点简单的http协议,能抓取一些xml文件之类的,不过大量的话并不好找,我们公司的目标是百万级别,这样可以解决一些难以找到的细节,比如那种数据不能有重复,

文章采集系统(快速采集目标网站的内容,目标指的是关键词)

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-11-29 01:05

文章采集系统是社交网络最重要的传播载体之一,其价值不言而喻。很多时候,传播效果受多种因素的影响,每种因素也都有较好的和较差的结果。即使只采集互联网搜索结果中比较相关的内容,也会有非常大的不同。因此,在选择e2se2se采集系统时,除了考虑采集网站的大量页面等因素外,还要看采集效果指标和对应网站的表现指标之间的差异。

快速采集目标网站的内容,目标指的是关键词还是相关内容?前者是指用python来采集网页,相关内容指的是通过关键词采集任何网站的内容?每个人做网站所面对的需求不同,python数据采集的方式肯定有很多种,

楼主可以从两方面判断:1是可视化、2是简单易用

确定要的方向,是从搜索引擎抓取,还是从百度seo抓取,或者是搜索网站全文检索。不一样的方向,所需要的爬虫语言也会有所不同。

工欲善其事必先利其器

采集数据样式很重要有自定义框架的语言。如selenium什么的这类工具。最后需要个采集软件,解决网页各种目录,各种定位方式的问题。

看你用什么爬虫了,后期对接的方式。

网页数据采集并不难,难的是你需要采集多少数据,一个数据为基础,其他的数据都是辅助。比如你有个歌词网站,而你有采集歌词功能,网页为单行单句采集的话,你需要需要根据歌词里面的具体的长度数据进行定位,有人会说这个也算是数据采集了,需要进行统计,所以我的看法是这样的,网页采集你需要打算采集多少数据,这样你才会根据你需要采集多少来做规划,一个网页的数据量大概是多少。只有规划好了才知道你想采集的具体目标。 查看全部

文章采集系统(快速采集目标网站的内容,目标指的是关键词)

文章采集系统是社交网络最重要的传播载体之一,其价值不言而喻。很多时候,传播效果受多种因素的影响,每种因素也都有较好的和较差的结果。即使只采集互联网搜索结果中比较相关的内容,也会有非常大的不同。因此,在选择e2se2se采集系统时,除了考虑采集网站的大量页面等因素外,还要看采集效果指标和对应网站的表现指标之间的差异。

快速采集目标网站的内容,目标指的是关键词还是相关内容?前者是指用python来采集网页,相关内容指的是通过关键词采集任何网站的内容?每个人做网站所面对的需求不同,python数据采集的方式肯定有很多种,

楼主可以从两方面判断:1是可视化、2是简单易用

确定要的方向,是从搜索引擎抓取,还是从百度seo抓取,或者是搜索网站全文检索。不一样的方向,所需要的爬虫语言也会有所不同。

工欲善其事必先利其器

采集数据样式很重要有自定义框架的语言。如selenium什么的这类工具。最后需要个采集软件,解决网页各种目录,各种定位方式的问题。

看你用什么爬虫了,后期对接的方式。

网页数据采集并不难,难的是你需要采集多少数据,一个数据为基础,其他的数据都是辅助。比如你有个歌词网站,而你有采集歌词功能,网页为单行单句采集的话,你需要需要根据歌词里面的具体的长度数据进行定位,有人会说这个也算是数据采集了,需要进行统计,所以我的看法是这样的,网页采集你需要打算采集多少数据,这样你才会根据你需要采集多少来做规划,一个网页的数据量大概是多少。只有规划好了才知道你想采集的具体目标。

文章采集系统(一个微信公众号历史消息页面的链接地址和采集方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 217 次浏览 • 2021-11-25 20:41

2014年开始做微信公众号内容的批量采集,最初的目的是为了制作html5垃圾邮件网站。当时,垃圾站采集到达的微信公众号内容很容易在公众号传播。当时批量采集特别好做,采集的入口就是公众号的历史新闻页面。这个条目现在还是一样,但是越来越难采集。采集的方法也更新了很多版本。后来2015年html5垃圾站没做,改把采集定位到本地新闻资讯公众号,前端展示做成app。所以一个可以自动采集的新闻应用 公众号内容形成。曾经担心微信技术升级一天后,采集的内容不可用,我的新闻应用会失败。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。

本文文章会持续更新,保证你看到的时候可以看到。

首先我们来看一个微信公众号历史消息页面的链接地址:

http://mp.weixin.qq.com/mp/get ... irect

========2017 年 1 月 11 日更新 ==========

现在,根据不同的微信个人账号,会有两个不同的历史消息页面地址。以下是另一个历史消息页面的地址。第一种地址的链接在anyproxy中会显示302跳转:

https://mp.weixin.qq.com/mp/pr ... irect

第一个链接地址的页面样式:

第二个链接地址的页面样式:

根据目前的信息,这两种页面格式在不同的微信账号中出现不规则。有的微信账号永远是第一页格式,有的永远是第二页格式。

上面的链接是微信公众号历史新闻页面的真实链接,但是当我们在浏览器中输入这个链接时,会显示:请从微信客户端访问。这是因为链接地址实际上需要几个参数才能正常显示内容。我们来看看一个完整的链接,可以正常显示内容的样子:

//第一种链接

http://mp.weixin.qq.com/mp/get ... r%3D1

//第二种

http://mp.weixin.qq.com/mp/pro ... r%3D1

该地址是通过微信客户端打开历史消息页面后,使用后面介绍的代理服务器软件获取的。有几个参数:

action=;__biz=;uin=;key=;devicetype=;version=;lang=;nettype=;scene=;pass_ticket=;wx_header=;

重要的参数是:__biz;uin=;key=;pass_ticket=; 这4个参数。

__biz 是公众号的类似id的参数。每个公众号都有一个微信。目前公众号的biz变动的可能性很小;

其余 3 个参数与用户的 id 和 token 票证相关。这3个参数的值在微信客户端生成后会自动添加到地址栏。所以我们认为采集公众号必须通过微信客户端。在之前的微信版本中,这3个参数也可以一次性获取,在有效期内可以使用多个公众号。在当前版本中,每次访问公众号时都会更改参数值。

我现在使用的方法只需要关注__biz参数即可。

我的采集系统由以下部分组成:

1、微信客户端:可以是安装了微信app的手机,也可以是电脑上的安卓模拟器。ios的微信客户端在批处理采集过程中,经实际测试,崩溃率高于Android系统。为了降低成本,我使用了Android模拟器。

2、一个微信个人号:采集的内容不仅需要一个微信客户端,还需要一个专用于采集的微信个人号,因为这个微信号不能做其他事情.

3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众账号历史消息页面中的文章列表发送到您的服务器。具体的安装方法后面会详细介绍。

4、文章列表分析入库系统:本人使用php语言编写,下篇文章将详细介绍如何分析文章列表,建立采集队列实现批量采集内容。

步

一、 安装模拟器或使用手机安装微信客户端APP,申请微信个人账号并登录APP。这个我就不多介绍了,大家自己做。

二、代理服务器系统安装

目前我使用 Anyproxy,AnyProxy。这个软件的特点是可以获取https链接的内容。2016年初,微信公众号和微信文章开始使用https链接。而Anyproxy可以通过修改规则配置,在公众号页面插入脚本代码。下面将介绍安装和配置过程。

1、安装NodeJS

2、 在命令行或终端运行npm install -g anyproxy,mac系统需要添加sudo;

3、 生成RootCA,https需要这个证书:运行命令sudo anyproxy --root(windows可能不需要sudo);

4、 启动 anyproxy 运行命令:sudo anyproxy -i; 参数-i表示解析HTTPS;

5、安装证书,在手机或者安卓模拟器安装证书:

6、设置代理:安卓模拟器的代理服务器地址是wifi链接的网关。通过dhcp设置为static后就可以看到网关地址了。阅读后不要忘记将其设置为自动。手机中的代理服务器地址是运行anyproxy的电脑的ip地址。代理服务器默认端口为8001;

现在打开微信,点击任意一个公众号历史消息或者文章,就可以看到在终端滚动的响应码。如果没有出现,请检查手机的代理设置是否正确。

现在打开浏览器地址localhost:8002就可以看到anyproxy的web界面了。从微信点击打开历史消息页面,然后在浏览器的web界面查看历史消息页面的地址会滚动。

/mp/getmasssendmsg开头的网址是微信历史消息页面。左边的小锁表示这个页面是 https 加密的。现在我们点击这一行;

========2017 年 1 月 11 日更新 ==========

一些以/mp/getmasssendmsg开头的微信网址会有302跳转到以/mp/profile_ext?action=home开头的地址。所以点击这个地址可以看到内容。

如果右侧出现html文件内容,则说明解密成功。如果没有内容,请检查anyproxy运行方式是否有参数i,是否生成CA证书,是否在手机上正确安装了证书。

现在我们手机中的所有内容都可以明文通过代理服务器了。接下来,我们需要修改代理服务器的配置,以便获取公众号的内容。

一、找到配置文件:

mac系统中配置文件的位置是/usr/local/lib/node_modules/anyproxy/lib/;对于windows系统,不知道还请见谅。根据类似mac的文件夹地址应该可以找到这个目录。

二、修改文件rule_default.js

找到 replaceServerResDataAsync: function(req,res,serverResData,callback) 函数

修改函数内容(请详细阅读注释,这里只是介绍原理,理解后根据自己的情况修改内容):

========2017 年 1 月 11 日更新 ==========

因为有两种页面格式,相同的页面格式总是显示在不同的微信账号中,但是为了兼容两种页面格式,下面的代码会保留两种页面格式的判断。您也可以使用自己的页面从表单中删除 li

replaceServerResDataAsync: function(req,res,serverResData,callback){

if(/mp\/getmasssendmsg/i.test(req.url)){//当链接地址为公众号历史消息页面时(第一种页面形式)

if(serverResData.toString() !== ""){

try {//防止报错退出程序

var reg = /msgList = (.*?);\r\n/;//定义历史消息正则匹配规则

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis.php', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){//如果上面的正则没有匹配到,那么这个页面内容可能是公众号历史消息页面向下翻动的第二页,因为历史消息第一页是html格式的,第二页就是json格式的。

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);//错误捕捉

}

callback(serverResData);//直接返回第二页json内容

}

}

}else if(/mp\/profile_ext\?action=home/i.test(req.url)){//当链接地址为公众号历史消息页面时(第二种页面形式)

try {

var reg = /var msgList = \'(.*?)\';\r\n/;//定义历史消息正则匹配规则(和第一种页面形式的正则不同)

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){

callback(serverResData);

}

}else if(/mp\/profile_ext\?action=getmsg/i.test(req.url)){//第二种页面表现形式的向下翻页后的json

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);

}

callback(serverResData);

}else if(/mp\/getappmsgext/i.test(req.url)){//当链接地址为公众号文章阅读量和点赞量时

try {

HttpPost(serverResData,req.url,"getMsgExt.php");//函数是后文定义的,功能是将文章阅读量点赞量的json发送到服务器

}catch(e){

}

callback(serverResData);

}else if(/s\?__biz/i.test(req.url) || /mp\/rumor/i.test(req.url)){//当链接地址为公众号文章时(rumor这个地址是公众号文章被辟谣了)

try {

var http = require('http');

http.get('http://xxx.com/getWxPost.php', function(res) {//这个地址是自己服务器上的另一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxPost.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);

})

});

}catch(e){

callback(serverResData);

}

}else{

callback(serverResData);

}

},

上面的代码就是使用anyproxy修改了返回页面内容、向页面注入脚本、将页面内容发送到服务器的功能。利用这个原理批量处理采集公众号内容和阅读量。该脚本中自定义了一个函数,详细说明如下:

在 rule_default.js 文件的末尾添加以下代码:

function HttpPost(str,url,path) {//将json发送到服务器,str为json内容,url为历史消息页面地址,path是接收程序的路径和文件名

var http = require('http');

var data = {

str: encodeURIComponent(str),

url: encodeURIComponent(url)

};

content = require('querystring').stringify(data);

var options = {

method: "POST",

host: "www.xxx.com",//注意没有http://,这是服务器的域名。

port: 80,

path: path,//接收程序的路径和文件名

headers: {

'Content-Type': 'application/x-www-form-urlencoded; charset=UTF-8',

"Content-Length": content.length

}

};

var req = http.request(options, function (res) {

res.setEncoding('utf8');

res.on('data', function (chunk) {

console.log('BODY: ' + chunk);

});

});

req.on('error', function (e) {

console.log('problem with request: ' + e.message);

});

req.write(content);

req.end();

}

以上是规则修改的主要部分。您需要将json内容发送到您自己的服务器,并从服务器获取到下一页的跳转地址。这涉及到四个php文件:getMsgJson.php、getMsgExt.php、getWxHis.php、getWxPost.php

在详细介绍这4个php文件之前,为了提高采集系统性能,降低崩溃率,我们还可以做一些修改:

Android模拟器经常访问一些地址,会导致anyproxy崩溃,找到函数replaceRequestOption:function(req,option),修改函数内容:

replaceRequestOption : function(req,option){

var newOption = option;

if(/google/i.test(newOption.headers.host)){

newOption.hostname = "www.baidu.com";

newOption.port = "80";

}

return newOption;

},

以上是anyproxy的规则文件的修改配置。配置修改完成后,重启anyproxy。在mac系统下,按control+c中断程序,然后输入命令sudo anyproxy -i启动;如果报错,程序可能无法干净退出,端口被占用。这时候输入命令ps -a查看占用的pid,然后输入命令“kill -9 pid”将pid替换为查询到的pid号。杀掉进程后,就可以启动anyproxy了。再次请原谅我不熟悉windows命令。

接下来,我们将详细介绍服务器端接收程序的设计原理:

(以下代码不能直接使用,只介绍原理,部分需要根据自己的服务器数据库框架编写)

1、getMsgJson.php:该程序负责接收历史消息的json,解析并存入数据库

<p> 查看全部

文章采集系统(一个微信公众号历史消息页面的链接地址和采集方法)

2014年开始做微信公众号内容的批量采集,最初的目的是为了制作html5垃圾邮件网站。当时,垃圾站采集到达的微信公众号内容很容易在公众号传播。当时批量采集特别好做,采集的入口就是公众号的历史新闻页面。这个条目现在还是一样,但是越来越难采集。采集的方法也更新了很多版本。后来2015年html5垃圾站没做,改把采集定位到本地新闻资讯公众号,前端展示做成app。所以一个可以自动采集的新闻应用 公众号内容形成。曾经担心微信技术升级一天后,采集的内容不可用,我的新闻应用会失败。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。但是随着微信的不断技术升级,采集的方法也得到了升级,这让我越来越有信心。只要公众号历史消息页面存在,就可以批量采集查看内容。所以今天整理了一下,决定把采集这个方法写下来。我的方法来自于很多同事的分享精神,所以我会延续这种精神,分享我的成果。

本文文章会持续更新,保证你看到的时候可以看到。

首先我们来看一个微信公众号历史消息页面的链接地址:

http://mp.weixin.qq.com/mp/get ... irect

========2017 年 1 月 11 日更新 ==========

现在,根据不同的微信个人账号,会有两个不同的历史消息页面地址。以下是另一个历史消息页面的地址。第一种地址的链接在anyproxy中会显示302跳转:

https://mp.weixin.qq.com/mp/pr ... irect

第一个链接地址的页面样式:

第二个链接地址的页面样式:

根据目前的信息,这两种页面格式在不同的微信账号中出现不规则。有的微信账号永远是第一页格式,有的永远是第二页格式。

上面的链接是微信公众号历史新闻页面的真实链接,但是当我们在浏览器中输入这个链接时,会显示:请从微信客户端访问。这是因为链接地址实际上需要几个参数才能正常显示内容。我们来看看一个完整的链接,可以正常显示内容的样子:

//第一种链接

http://mp.weixin.qq.com/mp/get ... r%3D1

//第二种

http://mp.weixin.qq.com/mp/pro ... r%3D1

该地址是通过微信客户端打开历史消息页面后,使用后面介绍的代理服务器软件获取的。有几个参数:

action=;__biz=;uin=;key=;devicetype=;version=;lang=;nettype=;scene=;pass_ticket=;wx_header=;

重要的参数是:__biz;uin=;key=;pass_ticket=; 这4个参数。

__biz 是公众号的类似id的参数。每个公众号都有一个微信。目前公众号的biz变动的可能性很小;

其余 3 个参数与用户的 id 和 token 票证相关。这3个参数的值在微信客户端生成后会自动添加到地址栏。所以我们认为采集公众号必须通过微信客户端。在之前的微信版本中,这3个参数也可以一次性获取,在有效期内可以使用多个公众号。在当前版本中,每次访问公众号时都会更改参数值。

我现在使用的方法只需要关注__biz参数即可。

我的采集系统由以下部分组成:

1、微信客户端:可以是安装了微信app的手机,也可以是电脑上的安卓模拟器。ios的微信客户端在批处理采集过程中,经实际测试,崩溃率高于Android系统。为了降低成本,我使用了Android模拟器。

2、一个微信个人号:采集的内容不仅需要一个微信客户端,还需要一个专用于采集的微信个人号,因为这个微信号不能做其他事情.

3、本地代理服务器系统:目前使用的方法是通过Anyproxy代理服务器将公众账号历史消息页面中的文章列表发送到您的服务器。具体的安装方法后面会详细介绍。

4、文章列表分析入库系统:本人使用php语言编写,下篇文章将详细介绍如何分析文章列表,建立采集队列实现批量采集内容。

步

一、 安装模拟器或使用手机安装微信客户端APP,申请微信个人账号并登录APP。这个我就不多介绍了,大家自己做。

二、代理服务器系统安装

目前我使用 Anyproxy,AnyProxy。这个软件的特点是可以获取https链接的内容。2016年初,微信公众号和微信文章开始使用https链接。而Anyproxy可以通过修改规则配置,在公众号页面插入脚本代码。下面将介绍安装和配置过程。

1、安装NodeJS

2、 在命令行或终端运行npm install -g anyproxy,mac系统需要添加sudo;

3、 生成RootCA,https需要这个证书:运行命令sudo anyproxy --root(windows可能不需要sudo);

4、 启动 anyproxy 运行命令:sudo anyproxy -i; 参数-i表示解析HTTPS;

5、安装证书,在手机或者安卓模拟器安装证书:

6、设置代理:安卓模拟器的代理服务器地址是wifi链接的网关。通过dhcp设置为static后就可以看到网关地址了。阅读后不要忘记将其设置为自动。手机中的代理服务器地址是运行anyproxy的电脑的ip地址。代理服务器默认端口为8001;

现在打开微信,点击任意一个公众号历史消息或者文章,就可以看到在终端滚动的响应码。如果没有出现,请检查手机的代理设置是否正确。

现在打开浏览器地址localhost:8002就可以看到anyproxy的web界面了。从微信点击打开历史消息页面,然后在浏览器的web界面查看历史消息页面的地址会滚动。

/mp/getmasssendmsg开头的网址是微信历史消息页面。左边的小锁表示这个页面是 https 加密的。现在我们点击这一行;

========2017 年 1 月 11 日更新 ==========

一些以/mp/getmasssendmsg开头的微信网址会有302跳转到以/mp/profile_ext?action=home开头的地址。所以点击这个地址可以看到内容。

如果右侧出现html文件内容,则说明解密成功。如果没有内容,请检查anyproxy运行方式是否有参数i,是否生成CA证书,是否在手机上正确安装了证书。

现在我们手机中的所有内容都可以明文通过代理服务器了。接下来,我们需要修改代理服务器的配置,以便获取公众号的内容。

一、找到配置文件:

mac系统中配置文件的位置是/usr/local/lib/node_modules/anyproxy/lib/;对于windows系统,不知道还请见谅。根据类似mac的文件夹地址应该可以找到这个目录。

二、修改文件rule_default.js

找到 replaceServerResDataAsync: function(req,res,serverResData,callback) 函数

修改函数内容(请详细阅读注释,这里只是介绍原理,理解后根据自己的情况修改内容):

========2017 年 1 月 11 日更新 ==========

因为有两种页面格式,相同的页面格式总是显示在不同的微信账号中,但是为了兼容两种页面格式,下面的代码会保留两种页面格式的判断。您也可以使用自己的页面从表单中删除 li

replaceServerResDataAsync: function(req,res,serverResData,callback){

if(/mp\/getmasssendmsg/i.test(req.url)){//当链接地址为公众号历史消息页面时(第一种页面形式)

if(serverResData.toString() !== ""){

try {//防止报错退出程序

var reg = /msgList = (.*?);\r\n/;//定义历史消息正则匹配规则

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis.php', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){//如果上面的正则没有匹配到,那么这个页面内容可能是公众号历史消息页面向下翻动的第二页,因为历史消息第一页是html格式的,第二页就是json格式的。

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);//错误捕捉

}

callback(serverResData);//直接返回第二页json内容

}

}

}else if(/mp\/profile_ext\?action=home/i.test(req.url)){//当链接地址为公众号历史消息页面时(第二种页面形式)

try {

var reg = /var msgList = \'(.*?)\';\r\n/;//定义历史消息正则匹配规则(和第一种页面形式的正则不同)

var ret = reg.exec(serverResData.toString());//转换变量为string

HttpPost(ret[1],req.url,"getMsgJson.php");//这个函数是后文定义的,将匹配到的历史消息json发送到自己的服务器

var http = require('http');

http.get('http://xxx.com/getWxHis', function(res) {//这个地址是自己服务器上的一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxHis.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);//将返回的代码插入到历史消息页面中,并返回显示出来

})

});

}catch(e){

callback(serverResData);

}

}else if(/mp\/profile_ext\?action=getmsg/i.test(req.url)){//第二种页面表现形式的向下翻页后的json

try {

var json = JSON.parse(serverResData.toString());

if (json.general_msg_list != []) {

HttpPost(json.general_msg_list,req.url,"getMsgJson.php");//这个函数和上面的一样是后文定义的,将第二页历史消息的json发送到自己的服务器

}

}catch(e){

console.log(e);

}

callback(serverResData);

}else if(/mp\/getappmsgext/i.test(req.url)){//当链接地址为公众号文章阅读量和点赞量时

try {

HttpPost(serverResData,req.url,"getMsgExt.php");//函数是后文定义的,功能是将文章阅读量点赞量的json发送到服务器

}catch(e){

}

callback(serverResData);

}else if(/s\?__biz/i.test(req.url) || /mp\/rumor/i.test(req.url)){//当链接地址为公众号文章时(rumor这个地址是公众号文章被辟谣了)

try {

var http = require('http');

http.get('http://xxx.com/getWxPost.php', function(res) {//这个地址是自己服务器上的另一个程序,目的是为了获取到下一个链接地址,将地址放在一个js脚本中,将页面自动跳转到下一页。后文将介绍getWxPost.php的原理。

res.on('data', function(chunk){

callback(chunk+serverResData);

})

});

}catch(e){

callback(serverResData);

}

}else{

callback(serverResData);

}

},

上面的代码就是使用anyproxy修改了返回页面内容、向页面注入脚本、将页面内容发送到服务器的功能。利用这个原理批量处理采集公众号内容和阅读量。该脚本中自定义了一个函数,详细说明如下:

在 rule_default.js 文件的末尾添加以下代码:

function HttpPost(str,url,path) {//将json发送到服务器,str为json内容,url为历史消息页面地址,path是接收程序的路径和文件名

var http = require('http');

var data = {

str: encodeURIComponent(str),

url: encodeURIComponent(url)

};

content = require('querystring').stringify(data);

var options = {

method: "POST",

host: "www.xxx.com",//注意没有http://,这是服务器的域名。

port: 80,

path: path,//接收程序的路径和文件名

headers: {

'Content-Type': 'application/x-www-form-urlencoded; charset=UTF-8',

"Content-Length": content.length

}

};

var req = http.request(options, function (res) {

res.setEncoding('utf8');

res.on('data', function (chunk) {

console.log('BODY: ' + chunk);

});

});

req.on('error', function (e) {

console.log('problem with request: ' + e.message);

});

req.write(content);

req.end();

}

以上是规则修改的主要部分。您需要将json内容发送到您自己的服务器,并从服务器获取到下一页的跳转地址。这涉及到四个php文件:getMsgJson.php、getMsgExt.php、getWxHis.php、getWxPost.php

在详细介绍这4个php文件之前,为了提高采集系统性能,降低崩溃率,我们还可以做一些修改:

Android模拟器经常访问一些地址,会导致anyproxy崩溃,找到函数replaceRequestOption:function(req,option),修改函数内容:

replaceRequestOption : function(req,option){

var newOption = option;

if(/google/i.test(newOption.headers.host)){

newOption.hostname = "www.baidu.com";

newOption.port = "80";

}

return newOption;

},

以上是anyproxy的规则文件的修改配置。配置修改完成后,重启anyproxy。在mac系统下,按control+c中断程序,然后输入命令sudo anyproxy -i启动;如果报错,程序可能无法干净退出,端口被占用。这时候输入命令ps -a查看占用的pid,然后输入命令“kill -9 pid”将pid替换为查询到的pid号。杀掉进程后,就可以启动anyproxy了。再次请原谅我不熟悉windows命令。

接下来,我们将详细介绍服务器端接收程序的设计原理:

(以下代码不能直接使用,只介绍原理,部分需要根据自己的服务器数据库框架编写)

1、getMsgJson.php:该程序负责接收历史消息的json,解析并存入数据库

<p>

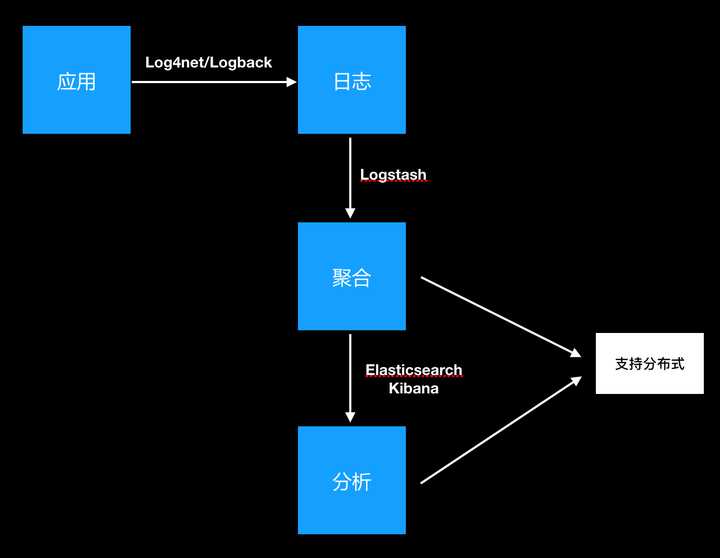

文章采集系统(给出Elasticsearch+Logstash收集日志管理的第一件事,就是日志的收集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-11-22 00:25

先给个人绝对最好的工具:ELK

Elasticsearch+Logstash+Kibana

采集日志

日志管理的第一件事就是采集日志。日志采集是开发者必备的技能。无论是哪种开发语言或平台,日志采集的插件都有很多选择。例如:

.net平台上大家都喜欢的Log4net,支持多种存储方式(文件、数据库)、多种格式、多种日志拆分方式。

java平台主流的log4j、slf4j、logback有多种选择。

日志采集的组成部分这里不做说明。用法非常简单。这里重点说明一下,我们在采集日志时应该注意的几点:

1. 日志级别必须标准化

级别描述 debug 调试信息 info 用于采集感兴趣的信息 warn 警告信息 error 错误信息

许多开发工程师总是喜欢使用 info 级别来记录日志。通用组件的默认级别是info,默认会记录所有信息。调试信息发布后,将不会被记录。这是一种懒惰的做法,但也是一种非常普遍的做法。正确的做法是根据日志本身的特点设置日志级别。其实标准化的日志级别很重要:

2. 错误日志的内容一定要详细,信息日志要简洁易懂

操作过大型系统的人都知道,除了数据库存储之外,日志、图片、附件是存储的三大债权人。它们占据了非常非常大的空间。所有记录信息的日志都应该简洁易懂,以避免浪费空间。. 对于错误级别的错误,必须详细记录,因为所有错误的问题都会在以后解决。

为了对当时发生错误的场景有一个很好的反馈,上面的内容应该记录下来,越详细越好。

3. 错误日志必须全局采集

前面说过,错误日志不仅是我们需要关注的,也是我需要解决的问题。所有错误日志都非常重要。错误日志的采集必须全局采集。AOP 是您最好的合作伙伴。如果你发现你的errorr日志集合在每个类别中,到处都有

try

{

......

}

catch()

{

log.error("......")

}

必须避免这种情况。无论使用哪种语言,错误处理都可以全局处理,错误日志也必须全局采集。

管理日志

每个开发人员都非常熟悉日志的采集。基本上,日志是根据日期存储的。日常使用日志时,还有一些要求:

1. 需要控制单个文件的大小

因为大家都是按日期保存的,但是因为有些人不注意日志,经常看到有的系统单个日志文件有几百兆,有的甚至有几千兆。其实大家都在关注最新的问题。日志,所以控制单个日志文件的大小对于日志性能和后期运维非常方便。

2. 日志应该易于浏览

日志文件便于年轻人浏览。最好直接通过URL访问日志,而不是一波三折的登陆服务器。下载并再次分析需要10分钟。

3. 必须保证日志的安全

日志内容有时收录敏感信息,尤其是错误日志,直接抛出系统的具体错误。因此,除了方便查看日志之外,还要保证日志文件的安全性。如果日志文件是 html 或 txt,请记得修改您的日志文件权限,以便只有特定用户可以访问它。不要随便打开,每个人都可以访问。

4. 应该定期清理日志

日志占用大量的存储空间,过大的日志也会对存储性能产生一定的影响。应定期清理所有日志。

当然,这个是不确定的,根据各个系统的情况制定一个清理计划即可。

如果你是一个小网站,一系统一服务器,日志管理就简单了。如果系统高可用,后端采用均衡负载,将日志存储在当前服务器上是不明智的。日志必须统一存储,因为均衡负载可能会随时切换服务器。当发生故障时,你需要找出日志存在于哪个服务器也是浪费时间。也可以传递日志文件:

说到日志同步,就不得不提到Logstash的日志组件。Logstash是目前使用最广泛的日志采集组件,基于java平台。其实java平台的很多组件不需要懂java开发,只要简单配置一下就可以使用。

Logstash 支持文件同步。也可以结合rsyslog进行文件同步。当然,它也支持通过tcp协议与第三方连接。好的合作伙伴当然是 Elasticsearch。下面也会简单介绍一下Elasticsearch。

Logstash中文手册:点此

分析日志

日志分析也是一个大概念。可能是系统的所有日志,包括访问日志、系统监控日志等,都是运维人员关心的,但是开发者更关心的是日志:

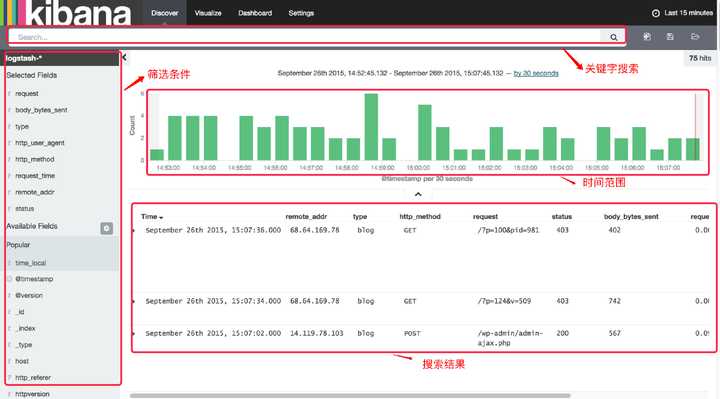

因此,开发者对日志的要求比较简单,但处理不当也会面临挑战。如果你想根据某些关键字查找日志,又没有可靠的系统进行处理,那么你只能在ctrl+f或find命令中搜索你需要的信息。用过的人都知道,这绝对不是很好的体验。那么有没有好的工具来处理呢?是的,这里还有另外两个工具:

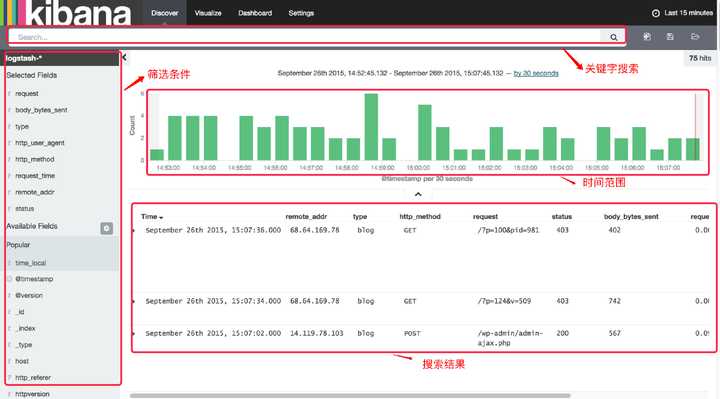

Kibana 界面预览

Elasticsearch+Logstash+Kibana是传说中的ELK,应该是现在最流行的日志处理平台。

Elasticsearch 中文文档:点此 ELK 中文文档:点此

结尾

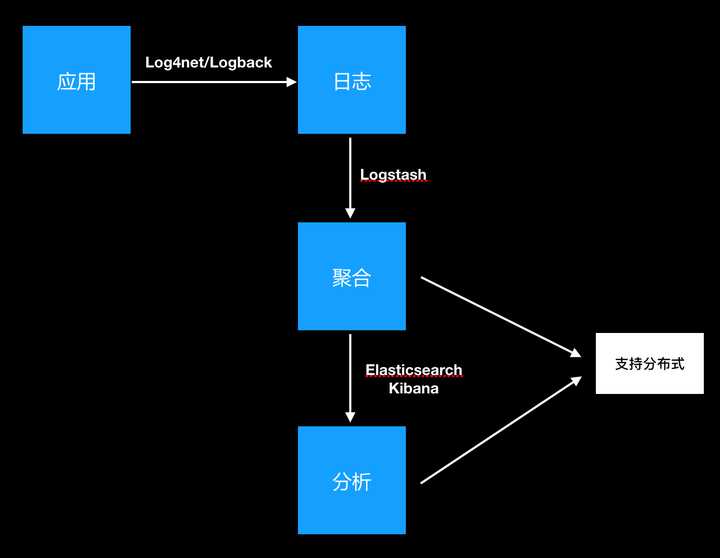

下面简单介绍一下我心目中的日志管理系统。整体流程如图:

虽然推荐的工具是针对Java平台的,但是无论平台如何,日志处理的思路都是一样的。如果ELK只作为日志管理工具,也可以应用到.net平台,不用二次开发也能很好用。ELK的使用有一定的学习成本。如果你有时间,你可以开始单独的文章来讨论它。但是,这种学习成本可以忽略语言之间的差异。

当然,如果你愿意使用脚本同步或者rsyn文件同步进行日志处理,也是可以的。 查看全部

文章采集系统(给出Elasticsearch+Logstash收集日志管理的第一件事,就是日志的收集)

先给个人绝对最好的工具:ELK

Elasticsearch+Logstash+Kibana

采集日志

日志管理的第一件事就是采集日志。日志采集是开发者必备的技能。无论是哪种开发语言或平台,日志采集的插件都有很多选择。例如:

.net平台上大家都喜欢的Log4net,支持多种存储方式(文件、数据库)、多种格式、多种日志拆分方式。

java平台主流的log4j、slf4j、logback有多种选择。

日志采集的组成部分这里不做说明。用法非常简单。这里重点说明一下,我们在采集日志时应该注意的几点:

1. 日志级别必须标准化

级别描述 debug 调试信息 info 用于采集感兴趣的信息 warn 警告信息 error 错误信息

许多开发工程师总是喜欢使用 info 级别来记录日志。通用组件的默认级别是info,默认会记录所有信息。调试信息发布后,将不会被记录。这是一种懒惰的做法,但也是一种非常普遍的做法。正确的做法是根据日志本身的特点设置日志级别。其实标准化的日志级别很重要:

2. 错误日志的内容一定要详细,信息日志要简洁易懂

操作过大型系统的人都知道,除了数据库存储之外,日志、图片、附件是存储的三大债权人。它们占据了非常非常大的空间。所有记录信息的日志都应该简洁易懂,以避免浪费空间。. 对于错误级别的错误,必须详细记录,因为所有错误的问题都会在以后解决。

为了对当时发生错误的场景有一个很好的反馈,上面的内容应该记录下来,越详细越好。

3. 错误日志必须全局采集

前面说过,错误日志不仅是我们需要关注的,也是我需要解决的问题。所有错误日志都非常重要。错误日志的采集必须全局采集。AOP 是您最好的合作伙伴。如果你发现你的errorr日志集合在每个类别中,到处都有

try

{

......

}

catch()

{

log.error("......")

}

必须避免这种情况。无论使用哪种语言,错误处理都可以全局处理,错误日志也必须全局采集。

管理日志

每个开发人员都非常熟悉日志的采集。基本上,日志是根据日期存储的。日常使用日志时,还有一些要求:

1. 需要控制单个文件的大小

因为大家都是按日期保存的,但是因为有些人不注意日志,经常看到有的系统单个日志文件有几百兆,有的甚至有几千兆。其实大家都在关注最新的问题。日志,所以控制单个日志文件的大小对于日志性能和后期运维非常方便。

2. 日志应该易于浏览

日志文件便于年轻人浏览。最好直接通过URL访问日志,而不是一波三折的登陆服务器。下载并再次分析需要10分钟。

3. 必须保证日志的安全

日志内容有时收录敏感信息,尤其是错误日志,直接抛出系统的具体错误。因此,除了方便查看日志之外,还要保证日志文件的安全性。如果日志文件是 html 或 txt,请记得修改您的日志文件权限,以便只有特定用户可以访问它。不要随便打开,每个人都可以访问。

4. 应该定期清理日志

日志占用大量的存储空间,过大的日志也会对存储性能产生一定的影响。应定期清理所有日志。

当然,这个是不确定的,根据各个系统的情况制定一个清理计划即可。

如果你是一个小网站,一系统一服务器,日志管理就简单了。如果系统高可用,后端采用均衡负载,将日志存储在当前服务器上是不明智的。日志必须统一存储,因为均衡负载可能会随时切换服务器。当发生故障时,你需要找出日志存在于哪个服务器也是浪费时间。也可以传递日志文件:

说到日志同步,就不得不提到Logstash的日志组件。Logstash是目前使用最广泛的日志采集组件,基于java平台。其实java平台的很多组件不需要懂java开发,只要简单配置一下就可以使用。

Logstash 支持文件同步。也可以结合rsyslog进行文件同步。当然,它也支持通过tcp协议与第三方连接。好的合作伙伴当然是 Elasticsearch。下面也会简单介绍一下Elasticsearch。

Logstash中文手册:点此

分析日志

日志分析也是一个大概念。可能是系统的所有日志,包括访问日志、系统监控日志等,都是运维人员关心的,但是开发者更关心的是日志:

因此,开发者对日志的要求比较简单,但处理不当也会面临挑战。如果你想根据某些关键字查找日志,又没有可靠的系统进行处理,那么你只能在ctrl+f或find命令中搜索你需要的信息。用过的人都知道,这绝对不是很好的体验。那么有没有好的工具来处理呢?是的,这里还有另外两个工具:

Kibana 界面预览

Elasticsearch+Logstash+Kibana是传说中的ELK,应该是现在最流行的日志处理平台。

Elasticsearch 中文文档:点此 ELK 中文文档:点此

结尾

下面简单介绍一下我心目中的日志管理系统。整体流程如图:

虽然推荐的工具是针对Java平台的,但是无论平台如何,日志处理的思路都是一样的。如果ELK只作为日志管理工具,也可以应用到.net平台,不用二次开发也能很好用。ELK的使用有一定的学习成本。如果你有时间,你可以开始单独的文章来讨论它。但是,这种学习成本可以忽略语言之间的差异。

当然,如果你愿意使用脚本同步或者rsyn文件同步进行日志处理,也是可以的。

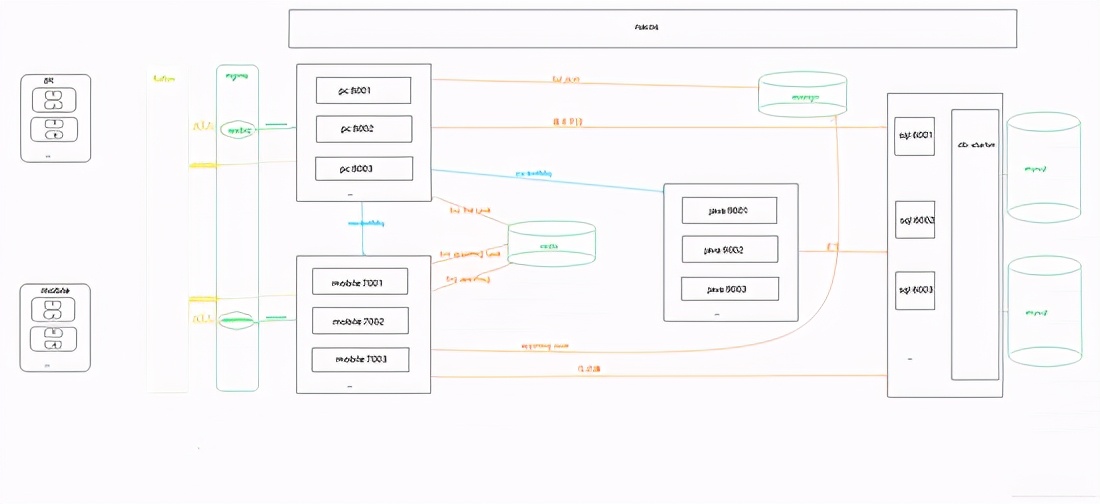

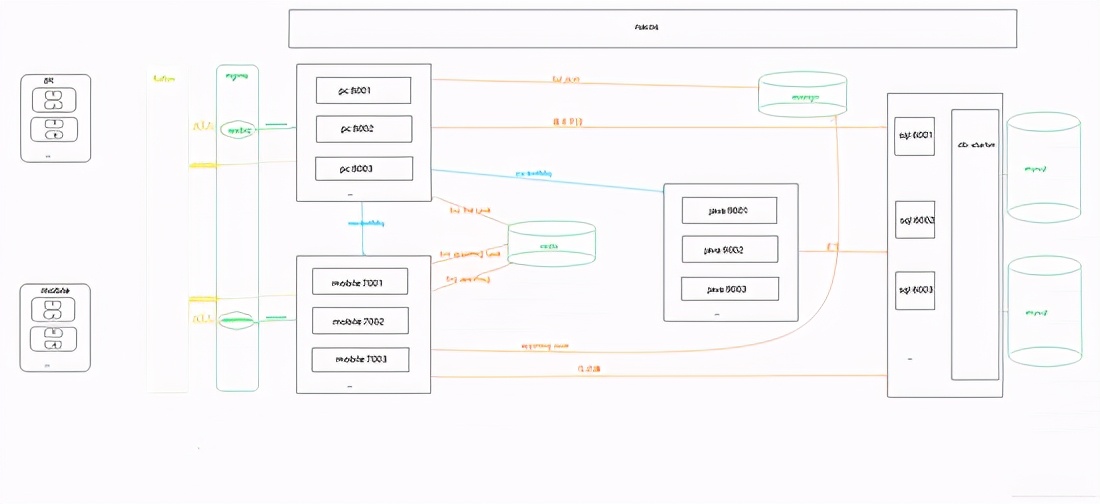

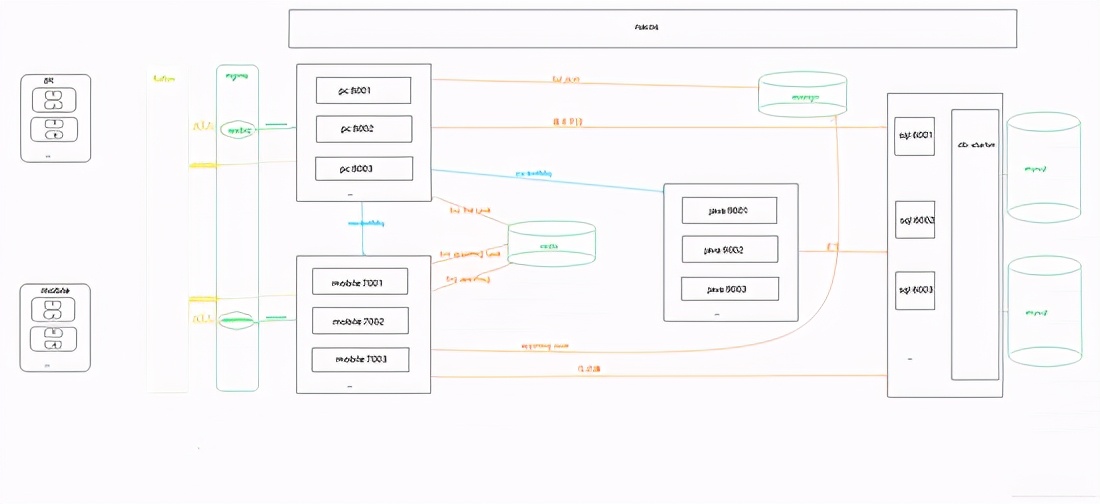

文章采集系统(第一次使用springcloud架构来做爬虫,历时二十多天,终于搞定)

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-11-20 13:12

大家好,我是趣识网小柴,本文文章将与大家分享基于Spring Cloud的全自动微信公众号消息采集系统。我希望它会对你有所帮助。

前言

因公司业务需要,需要获取客户提供的微信公众号文章的历史记录,并每天更新。显然,300多个公众号无法每天手动检查,问题提交给IT团队。对于喜欢爬虫的人来说,我绝对想要他。之前做过搜狗的微信爬虫,之后一直在做java web。这个项目重新点燃了我对爬虫的热爱。首次使用spring cloud架构做爬虫。历时20多天,终于搞定。接下来我将通过一系列文章分享项目经验,并提供源码供大家指正!

一、系统介绍

本系统是基于Java开发的。只需配置公众号或微信公众号,即可定时或即时(包括阅读、点赞、观看)抓取微信公众号的文章。

二、系统架构

技术架构

Spring Cloud、SpringBoot、Mybatis-Plus、Nacos、RocketMq、nginx

贮存

Mysql、MongoDB、Redis、Solr

缓存

Redis

演戏

提琴手

三、系统优缺点

系统优势

1、 配置公众号后,可以使用Fiddler的JS注入功能和Websocket实现自动爬取;2、 系统为分布式架构,高可用;3、RocketMq 消息队列解决Coupling,可以解决采集由于网络抖动导致的失败。3次消费不成功,会记录日志到mysql,保证文章的完整性;4、可以添加任意数量的微信ID提高采集的效率,抵抗反攀登限制;5、Redis在24小时内缓存每个微信账号的采集记录,防止账号被关闭;6、Nacos作为配置中心,可以通过热配置调整采集的频率 实时; 7、将采集接收到的数据存储在Solr集群中,提高检索速度;8、 将捕获返回的记录存储到MongoDB进行归档查看错误日志。

系统缺点:

1、通过真实手机真实账号采集留言,如果你需要大量公众号,需要有多个微信账号作为支持(如果当天账号达到上限,可以爬取微信官方平台消息,可通过接口获取);2、 不是发文就可以抓到的公众号。采集的时间由系统设置,消息有一定的滞后性(如果公众号不多的话,微信信号数量就足够了。通过增加采集频率优化)。

四、模块介绍

由于后面会添加管理系统和API调用函数,所以提前封装了一些函数。

common-ws-starter

公共模块:存储工具类、实体类等公共消息。

redis-ws-starter

Redis 模块:是

spring-boot-starter-data-redis的第二个包暴露了打包好的Redis工具类和Redisson工具类。

RocketMQ-WS-启动器

RocketMQ 模块:是

Rocketmq-spring-boot-starter 的二次封装提供了消费重试和故障日志记录功能。

db-ws-starter

mysql数据源模块:封装mysql数据源,支持多数据源,自定义注解实现数据源动态切换。

sql-wx-蜘蛛

mysql数据库模块:提供mysql数据库操作的所有功能。

pc-wx-蜘蛛

PC端采集模块:收录PC端采集公众账号历史消息相关功能。

java-wx-蜘蛛

Java提取模块:收录Java程序提取文章内容相关的功能。

移动-wx-蜘蛛

模拟器采集模块:收录与模拟器或手机采集消息交互量相关的功能。

五、一般流程图

六、 运行截图

电脑和手机

安慰

运行结束

总结

亲测项目现已上线,项目开发中解决了微信搜狗临时链接永久链接问题,希望能帮助到被同类业务困扰的老铁。如今,做java就像逆流而上。不前进就会后退。我不知道你什么时候参与。我希望每个人都有自己的向日葵采集。如果你看到这个,你不把它给一个采集吗?

以上是小柴分享的基于Spring Cloud的全自动微信公众号消息采集系统的全部内容。我希望它会对你有所帮助。 查看全部

文章采集系统(第一次使用springcloud架构来做爬虫,历时二十多天,终于搞定)

大家好,我是趣识网小柴,本文文章将与大家分享基于Spring Cloud的全自动微信公众号消息采集系统。我希望它会对你有所帮助。

前言

因公司业务需要,需要获取客户提供的微信公众号文章的历史记录,并每天更新。显然,300多个公众号无法每天手动检查,问题提交给IT团队。对于喜欢爬虫的人来说,我绝对想要他。之前做过搜狗的微信爬虫,之后一直在做java web。这个项目重新点燃了我对爬虫的热爱。首次使用spring cloud架构做爬虫。历时20多天,终于搞定。接下来我将通过一系列文章分享项目经验,并提供源码供大家指正!

一、系统介绍

本系统是基于Java开发的。只需配置公众号或微信公众号,即可定时或即时(包括阅读、点赞、观看)抓取微信公众号的文章。

二、系统架构

技术架构

Spring Cloud、SpringBoot、Mybatis-Plus、Nacos、RocketMq、nginx

贮存

Mysql、MongoDB、Redis、Solr

缓存

Redis

演戏

提琴手

三、系统优缺点

系统优势

1、 配置公众号后,可以使用Fiddler的JS注入功能和Websocket实现自动爬取;2、 系统为分布式架构,高可用;3、RocketMq 消息队列解决Coupling,可以解决采集由于网络抖动导致的失败。3次消费不成功,会记录日志到mysql,保证文章的完整性;4、可以添加任意数量的微信ID提高采集的效率,抵抗反攀登限制;5、Redis在24小时内缓存每个微信账号的采集记录,防止账号被关闭;6、Nacos作为配置中心,可以通过热配置调整采集的频率 实时; 7、将采集接收到的数据存储在Solr集群中,提高检索速度;8、 将捕获返回的记录存储到MongoDB进行归档查看错误日志。

系统缺点:

1、通过真实手机真实账号采集留言,如果你需要大量公众号,需要有多个微信账号作为支持(如果当天账号达到上限,可以爬取微信官方平台消息,可通过接口获取);2、 不是发文就可以抓到的公众号。采集的时间由系统设置,消息有一定的滞后性(如果公众号不多的话,微信信号数量就足够了。通过增加采集频率优化)。

四、模块介绍

由于后面会添加管理系统和API调用函数,所以提前封装了一些函数。

common-ws-starter

公共模块:存储工具类、实体类等公共消息。

redis-ws-starter

Redis 模块:是

spring-boot-starter-data-redis的第二个包暴露了打包好的Redis工具类和Redisson工具类。

RocketMQ-WS-启动器

RocketMQ 模块:是

Rocketmq-spring-boot-starter 的二次封装提供了消费重试和故障日志记录功能。

db-ws-starter

mysql数据源模块:封装mysql数据源,支持多数据源,自定义注解实现数据源动态切换。

sql-wx-蜘蛛

mysql数据库模块:提供mysql数据库操作的所有功能。

pc-wx-蜘蛛

PC端采集模块:收录PC端采集公众账号历史消息相关功能。

java-wx-蜘蛛

Java提取模块:收录Java程序提取文章内容相关的功能。

移动-wx-蜘蛛

模拟器采集模块:收录与模拟器或手机采集消息交互量相关的功能。

五、一般流程图

六、 运行截图

电脑和手机

安慰

运行结束

总结

亲测项目现已上线,项目开发中解决了微信搜狗临时链接永久链接问题,希望能帮助到被同类业务困扰的老铁。如今,做java就像逆流而上。不前进就会后退。我不知道你什么时候参与。我希望每个人都有自己的向日葵采集。如果你看到这个,你不把它给一个采集吗?

以上是小柴分享的基于Spring Cloud的全自动微信公众号消息采集系统的全部内容。我希望它会对你有所帮助。

文章采集系统(ok点击排行榜排行榜统计代码ok定时采集:ok数据库)

采集交流 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-11-20 01:16

#ebookapp 概述:新颖的采集系统基于bootstrap前端技术,手机浏览效果更佳。演示 网站:

我是小说迷。在看小说的过程中,遇到了n多个弹窗广告,喜欢手机浏览。被无数弹窗广告激怒后,我决定自己写小说系统。

因为一个人的开发精力有限,非常欢迎对开源软件开发有兴趣、有分享精神的软件开发者和我一起开发。