文章实时采集

2.框架实时采集处理方案,Streaming处理

采集交流 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2021-08-15 21:23

1.Background

在实际生产中,我们经常会遇到像kafka这样的流式数据,而原创数据并不是我们想要的,需要通过一定的逻辑处理转换成我们需要的数据。针对这种需求,本文采用NiFi+Spark Streaming技术方案设计了一种通用的实时采集处理各种外部数据源的方法。

2.Framework

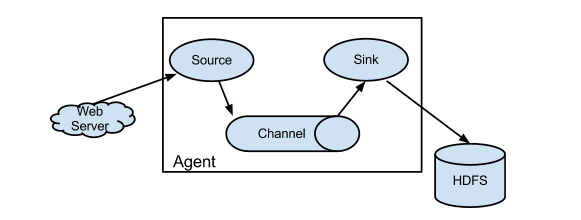

实时采集处理方案由两部分组成:数据采集和流处理。数据采集来自NiFi中的任务流采集外部数据源,数据写入指定端口。在流式处理中,Spark Streaming从NiFi中的指定端口读取数据,进行相关的数据转换,然后写入Kafka。整个流式采集处理框架如下:

流媒体框架

3.数据采集

NiFi 是一个易于使用、功能强大且可靠的数据提取、数据处理和分发系统。 NiFi 专为数据流而设计。支持指标图的高度可配置的数据路由、转换和系统中介逻辑,支持从多种数据源动态拉取数据。它由 NSA 开源,是顶级 Apache 项目之一。详情请见:。

在NiFi中,会根据不同的数据源创建相应的模板,然后通过模板部署任务流。任务流将采集data 源数据,然后写入指定端口。对于不同的数据源,数据采集的方法是不同的。比如数据库类型的数据源需要对采集使用记录水位和增量拉取的方法。为了方便后续的数据转换,这里将数据统一转换为csv格式。比如mongodb的json数据会根据字段展开到第一层,对象值会被序列化成字符串。

最简单的任务流程如下:

任务流程

GetFile本身读取的文件是带有标题的csv格式,如下图:

id,name,age

1000,name1,20

1001,name2,21

1002,name3,22

UpdateAttribute 将设置目标字段名称、类型和转换规则,如下所示:

tid|string|.select(df("*"), df("id").cast("string").as("tid"))

tname|string|.select(df("*"), df("name").cast("string").as("tname"))

tage|string|.select(df("*"), df("age").cast("int").as("tage"))

4.流处理

Spark Streaming 是一个基于 Spark 的实时计算框架。它是 Spark Core API 的扩展。可实现流式数据的实时处理,具有良好的可扩展性、高吞吐量和容错性。

Spark Streaming 连接 NiFi 数据并执行流式处理步骤:

1.初始化上下文

final SparkConf sparkConf = new SparkConf().setAppName(appName).setMaster(sparkMaster);

JavaStreamingContext ssc = new JavaStreamingContext(sparkConf, new Duration(1000L));

2.连接nifi中指定的输出端口

SiteToSiteClientConfig config = new SiteToSiteClient.Builder().url(nifiUrl).portName(nifiPort).buildConfig();

final JavaReceiverInputDStream packetStream = ssc.receiverStream(new NiFiReceiver(config, StorageLevel.MEMORY_AND_DISK()));

3.读取端口上的流数据和属性

JavaDStream ds = packetStream.map(new Function() {

@Override

public NifiFeed call(NiFiDataPacket dataPacket) throws Exception {

return new NifiFeed(new String(dataPacket.getContent()), dataPacket.getAttributes());

}

});

NifiFeed 是一种用于存储数据和属性的自定义数据结构。

4.数据转换

ds.foreachRDD(new VoidFunction() {

@Override

public void call(JavaRDD rdd) throws Exception {

rdd.foreachPartition(new VoidFunction() {

@Override

public void call(Iterator iterator) throws Exception {

try {

while (iterator.hasNext()) {

//TODO:执行数据转换

}

} catch (Exception e) {

//TODO:异常处理

}

}

});

}

});

数据转换需要动态执行属性中的代码。这里使用jexl开源库动态执行java代码。详情请见:。

5.启动服务

ssc.start();

ssc.awaitTermination();

5.Summary

本方案使用NiFi处理采集数据,然后通过Spark Streaming流引擎,将采集数据按照规定进行转换,生成新数据发送到Kafka系统进行后续服务或处理,如Kylin Streaming模型构建。 查看全部

2.框架实时采集处理方案,Streaming处理

1.Background

在实际生产中,我们经常会遇到像kafka这样的流式数据,而原创数据并不是我们想要的,需要通过一定的逻辑处理转换成我们需要的数据。针对这种需求,本文采用NiFi+Spark Streaming技术方案设计了一种通用的实时采集处理各种外部数据源的方法。

2.Framework

实时采集处理方案由两部分组成:数据采集和流处理。数据采集来自NiFi中的任务流采集外部数据源,数据写入指定端口。在流式处理中,Spark Streaming从NiFi中的指定端口读取数据,进行相关的数据转换,然后写入Kafka。整个流式采集处理框架如下:

流媒体框架

3.数据采集

NiFi 是一个易于使用、功能强大且可靠的数据提取、数据处理和分发系统。 NiFi 专为数据流而设计。支持指标图的高度可配置的数据路由、转换和系统中介逻辑,支持从多种数据源动态拉取数据。它由 NSA 开源,是顶级 Apache 项目之一。详情请见:。

在NiFi中,会根据不同的数据源创建相应的模板,然后通过模板部署任务流。任务流将采集data 源数据,然后写入指定端口。对于不同的数据源,数据采集的方法是不同的。比如数据库类型的数据源需要对采集使用记录水位和增量拉取的方法。为了方便后续的数据转换,这里将数据统一转换为csv格式。比如mongodb的json数据会根据字段展开到第一层,对象值会被序列化成字符串。

最简单的任务流程如下:

任务流程

GetFile本身读取的文件是带有标题的csv格式,如下图:

id,name,age

1000,name1,20

1001,name2,21

1002,name3,22

UpdateAttribute 将设置目标字段名称、类型和转换规则,如下所示:

tid|string|.select(df("*"), df("id").cast("string").as("tid"))

tname|string|.select(df("*"), df("name").cast("string").as("tname"))

tage|string|.select(df("*"), df("age").cast("int").as("tage"))

4.流处理

Spark Streaming 是一个基于 Spark 的实时计算框架。它是 Spark Core API 的扩展。可实现流式数据的实时处理,具有良好的可扩展性、高吞吐量和容错性。

Spark Streaming 连接 NiFi 数据并执行流式处理步骤:

1.初始化上下文

final SparkConf sparkConf = new SparkConf().setAppName(appName).setMaster(sparkMaster);

JavaStreamingContext ssc = new JavaStreamingContext(sparkConf, new Duration(1000L));

2.连接nifi中指定的输出端口

SiteToSiteClientConfig config = new SiteToSiteClient.Builder().url(nifiUrl).portName(nifiPort).buildConfig();

final JavaReceiverInputDStream packetStream = ssc.receiverStream(new NiFiReceiver(config, StorageLevel.MEMORY_AND_DISK()));

3.读取端口上的流数据和属性

JavaDStream ds = packetStream.map(new Function() {

@Override

public NifiFeed call(NiFiDataPacket dataPacket) throws Exception {

return new NifiFeed(new String(dataPacket.getContent()), dataPacket.getAttributes());

}

});

NifiFeed 是一种用于存储数据和属性的自定义数据结构。

4.数据转换

ds.foreachRDD(new VoidFunction() {

@Override

public void call(JavaRDD rdd) throws Exception {

rdd.foreachPartition(new VoidFunction() {

@Override

public void call(Iterator iterator) throws Exception {

try {

while (iterator.hasNext()) {

//TODO:执行数据转换

}

} catch (Exception e) {

//TODO:异常处理

}

}

});

}

});

数据转换需要动态执行属性中的代码。这里使用jexl开源库动态执行java代码。详情请见:。

5.启动服务

ssc.start();

ssc.awaitTermination();

5.Summary

本方案使用NiFi处理采集数据,然后通过Spark Streaming流引擎,将采集数据按照规定进行转换,生成新数据发送到Kafka系统进行后续服务或处理,如Kylin Streaming模型构建。

文章实时采集之js与css采集,包括可视化采集与资讯爬虫采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-08-13 18:06

文章实时采集之js与css采集,包括可视化采集与资讯爬虫采集,有相关项目可以私信我。

目前主要针对web在做,发展形势不错,市场大,需求多,在做得技术也很多。互联网获取信息首先网上很多信息是空的,需要进行发现,然后推送给用户看,需要定向和采集。

谈一下我个人了解到的目前主要有:

1)javascript

2)文本处理基本上你懂点javascript就行,这个很多需求是给不懂的团队使用,当然javascript处理网页中文本信息还是非常方便,

3)图像处理的很多公司都做出有有像素级别的提取

4)定制化这一块在各个项目中都可以看到,

5)性能这块内存机制不同速度上会有相应的影响,

6)采集质量(bloomfilter-webeventgrabber)大家在使用某app的某个公众号后台很多公众号做了一些优化,

作为广告公司实习生,

1)有朋友分享过,阿里的猴子采集器采集方法在google上有结果,所以大家可以试试。

2)手工分词,这个速度明显慢,还容易出错。

3)由于网页不可避免地不具有唯一性,如果爬取某些站点中使用ip访问网页的ip不唯一(有的域名是指向多个网站的),则蜘蛛有可能访问其他网站的ip。

4)爬虫时间不宜过长,防止频繁发起网络请求,或者重定向,因为爬虫内存过于饱和。

5)爬虫最终会并发请求数超过系统底线,爬虫根本没法从目标站点中获取信息,无法达到爬取准确率90%的要求。

6)除了基本的解析和去重等采集技术外,大量数据需要进行分库分表,可以采用分段爬虫实现。

7)我了解到的,即使是分库分表,很多大网站对于重定向比较敏感,往往需要重定向得比较久,如果电脑配置不太高可能会被卡在某个页面上;比如有个网站有x十秒,我们爬了半小时。这个页面即使对于正常用户也可能有很多信息没有收集到。比如有的网站可能要求只有x个人能看到。

8)浏览器上一些系统的ui做的不好。比如页面里边有很多验证码,做一些奇怪的验证码页面上也不容易找到正确的验证码。比如老年人看网站,可能会被弹出的彩蛋吓到并且怕自己也会瞎。最后我还是建议各位找师兄师姐买一台正版web抓包工具,甚至花一两百做一套好用的定向的工具。基本就可以分析自己需要什么样的网站, 查看全部

文章实时采集之js与css采集,包括可视化采集与资讯爬虫采集

文章实时采集之js与css采集,包括可视化采集与资讯爬虫采集,有相关项目可以私信我。

目前主要针对web在做,发展形势不错,市场大,需求多,在做得技术也很多。互联网获取信息首先网上很多信息是空的,需要进行发现,然后推送给用户看,需要定向和采集。

谈一下我个人了解到的目前主要有:

1)javascript

2)文本处理基本上你懂点javascript就行,这个很多需求是给不懂的团队使用,当然javascript处理网页中文本信息还是非常方便,

3)图像处理的很多公司都做出有有像素级别的提取

4)定制化这一块在各个项目中都可以看到,

5)性能这块内存机制不同速度上会有相应的影响,

6)采集质量(bloomfilter-webeventgrabber)大家在使用某app的某个公众号后台很多公众号做了一些优化,

作为广告公司实习生,

1)有朋友分享过,阿里的猴子采集器采集方法在google上有结果,所以大家可以试试。

2)手工分词,这个速度明显慢,还容易出错。

3)由于网页不可避免地不具有唯一性,如果爬取某些站点中使用ip访问网页的ip不唯一(有的域名是指向多个网站的),则蜘蛛有可能访问其他网站的ip。

4)爬虫时间不宜过长,防止频繁发起网络请求,或者重定向,因为爬虫内存过于饱和。

5)爬虫最终会并发请求数超过系统底线,爬虫根本没法从目标站点中获取信息,无法达到爬取准确率90%的要求。

6)除了基本的解析和去重等采集技术外,大量数据需要进行分库分表,可以采用分段爬虫实现。

7)我了解到的,即使是分库分表,很多大网站对于重定向比较敏感,往往需要重定向得比较久,如果电脑配置不太高可能会被卡在某个页面上;比如有个网站有x十秒,我们爬了半小时。这个页面即使对于正常用户也可能有很多信息没有收集到。比如有的网站可能要求只有x个人能看到。

8)浏览器上一些系统的ui做的不好。比如页面里边有很多验证码,做一些奇怪的验证码页面上也不容易找到正确的验证码。比如老年人看网站,可能会被弹出的彩蛋吓到并且怕自己也会瞎。最后我还是建议各位找师兄师姐买一台正版web抓包工具,甚至花一两百做一套好用的定向的工具。基本就可以分析自己需要什么样的网站,

实时数仓架构设计思路数据流转与处理,需要综合考虑投入产出

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-08-11 02:15

01 什么是实时数据仓库

首先要明确什么是实时数据仓库。百度百科和维基百科均未给出具体说明。什么是实时数据仓库?是否可以通过实时流式获取实时数据,即实时数据仓库?换句话说,流批处理集成是实时数据仓库?还是完全采用实时方式,采集和实时计算都是实时数据仓库?

对于这个问题,不同的公司可能有不同的答案。有些人认为提供实时广告牌或实时报告是实时数据仓库;其他人可能认为数据仓库提供的数据必须是实时的才能被认为是实时数据仓库。事实上,这个问题没有标准答案。不同的人、场景和公司对它的理解不同。记得有个老板讲过管理岗位和技术岗位的区别,其中之一是:

对于一件事或需要,T帖子的答案很明确:要么可以做,要么不能做; M贴的回答看似明确,但其实有多种解读。 [这不是老油条吗,哈哈]

所以从不同的角度解读实时数仓,实时数仓的定义是不同的;一般有几种定义:

可以看出理解不同,构建实时数据仓库的复杂度也不同。但最终构建什么样的实时数仓还是由业务驱动,需要综合考虑输入输出。

02 实时数据仓库架构设计思路

实时或离线数据仓库中的数据流向和处理基本类似于下图,因为分层是一种非常有效的数据管理方式,所以说到如何管理实时数据仓库,首先要考虑的是处理逻辑也是分层的。

从上图可以看出,在设计实时数据仓库解决方案时,需要考虑以下几点(不是设计最强大的技术方案,而是设计的方案最适合业务场景和资源。;有时候厉害的技术方案会增加技术复杂度和运维难度,考验我们的控制能力,所以我们选择的不是技术含量最高的方案,而是最适合我们实际情况的方案):

数据集成和存储层流批量集成主要产生以下问题:

03 几种实时数据仓库架构分析

根据这些是否集成:“数据是否集成,流和批处理是否集成,存储层是否与批处理流集成”,“ETL逻辑流是否与批处理集成”,“是否ETL计算引擎与“流批处理”集成,不同流集成。这种组合将设计一个不同的实时数据仓库架构。比较经典的架构有Lambda和Kappa;还有美团实时数仓架构(实时数据生产+实时分析引擎)和阿里的流批集成架构(Lambda+Kappa),以下是对这些实时数仓架构的总结。 Lambda 数据仓库架构

/img?url=https://mmbiz.qpic.cn/mmbiz_pn ... 3Dpng

Lambda 有 Batch Layer(批处理)和 Speed Layer(流处理)。然后将批处理和流结果拼接在一起。 Lambda 架构具有数据不变性的特性,可以避免人为引入错误问题,支持数据重新运行,分离复杂的流处理。但是,Batch Layer 和 Speed Layer 往往选择不同的组件,因为它们需要满足不同的场景。

而且,写过Storm的人都知道,Storm的代码写起来很痛苦(Trident会改进)。因此,我们需要准备两套代码。批处理和流处理必须实现相同的逻辑两次。

Lambda 架构问题:

Kappa 架构

Kreps 提出了另一个维度的思考,我们能否改进和使用流处理系统来构建大数据系统?提出以构建流为核心,构建数据系统。并且,通过重放历史数据来实现数据的重新运行。

这种以流处理为核心构建的数据系统,被Kreps称为“Kappa架构”。 Kappa 和 Lambda 都是希腊字母符号。这种架构比 Lambda 架构简单得多。就是把原来的批处理改为流处理。它没有Lambda架构中的Batch Layer、Speed Layer和Serve Layer。

/img?url=https://mmbiz.qpic.cn/mmbiz_pn ... 3Dpng

Lambda 架构问题:

实时数据生产+实时分析引擎

/img?url=https://mmbiz.qpic.cn/mmbiz_pn ... 3Dpng

上图是美团实时数据仓库的架构设计。数据从日志采集统一到消息队列,再到数据流的ETL过程。基础数据流的构建是统一的。之后,针对日志的实时性,实时大屏应用采用了实时流计算。

使用实时OLAP批处理进行Binlog业务分析。美团的实时数仓架构主要是为了解决实时OLAP在实时处理上的一些困难。

实时处理面临的几个困难:

Lambda+Kappa

从上图可以看出,阿里的实时数仓架构同时结合了Lambda和Kappa;数据整合不使用流批整合,分别通过实时采集和数据同步方式采集实现流和批数据。集成ETL逻辑流批,让用户只写一套代码,平台自动翻译成Flink Batch任务和Flink Stream任务,同时写入一个Holo表,完成对表达的统一计算层。存储层流和批分开存储,但可以实现流批存储的透明性,查询逻辑完全一致。

04 总结

架构设计不是设计最强大的技术方案,而是设计最适合业务场景和资源条件的方案。有时候很棒的技术方案会增加运维的技术复杂度和难度,需要更高的成本来控制。因此,我们选择的并不是技术最先进的方案,而是最适合我们实际情况的技术架构。

在实时数据仓库架构的设计中,主要考虑“数据集成是否与流和批处理集成,存储层是否与批处理集成”,“ETL逻辑流是否与批处理集成”,“ ETL计算引擎是否与流批集成”;权衡这些集成带来的问题,我们设计了适合业务场景的实时数据仓库架构。 查看全部

实时数仓架构设计思路数据流转与处理,需要综合考虑投入产出

01 什么是实时数据仓库

首先要明确什么是实时数据仓库。百度百科和维基百科均未给出具体说明。什么是实时数据仓库?是否可以通过实时流式获取实时数据,即实时数据仓库?换句话说,流批处理集成是实时数据仓库?还是完全采用实时方式,采集和实时计算都是实时数据仓库?

对于这个问题,不同的公司可能有不同的答案。有些人认为提供实时广告牌或实时报告是实时数据仓库;其他人可能认为数据仓库提供的数据必须是实时的才能被认为是实时数据仓库。事实上,这个问题没有标准答案。不同的人、场景和公司对它的理解不同。记得有个老板讲过管理岗位和技术岗位的区别,其中之一是:

对于一件事或需要,T帖子的答案很明确:要么可以做,要么不能做; M贴的回答看似明确,但其实有多种解读。 [这不是老油条吗,哈哈]

所以从不同的角度解读实时数仓,实时数仓的定义是不同的;一般有几种定义:

可以看出理解不同,构建实时数据仓库的复杂度也不同。但最终构建什么样的实时数仓还是由业务驱动,需要综合考虑输入输出。

02 实时数据仓库架构设计思路

实时或离线数据仓库中的数据流向和处理基本类似于下图,因为分层是一种非常有效的数据管理方式,所以说到如何管理实时数据仓库,首先要考虑的是处理逻辑也是分层的。

从上图可以看出,在设计实时数据仓库解决方案时,需要考虑以下几点(不是设计最强大的技术方案,而是设计的方案最适合业务场景和资源。;有时候厉害的技术方案会增加技术复杂度和运维难度,考验我们的控制能力,所以我们选择的不是技术含量最高的方案,而是最适合我们实际情况的方案):

数据集成和存储层流批量集成主要产生以下问题:

03 几种实时数据仓库架构分析

根据这些是否集成:“数据是否集成,流和批处理是否集成,存储层是否与批处理流集成”,“ETL逻辑流是否与批处理集成”,“是否ETL计算引擎与“流批处理”集成,不同流集成。这种组合将设计一个不同的实时数据仓库架构。比较经典的架构有Lambda和Kappa;还有美团实时数仓架构(实时数据生产+实时分析引擎)和阿里的流批集成架构(Lambda+Kappa),以下是对这些实时数仓架构的总结。 Lambda 数据仓库架构

/img?url=https://mmbiz.qpic.cn/mmbiz_pn ... 3Dpng

Lambda 有 Batch Layer(批处理)和 Speed Layer(流处理)。然后将批处理和流结果拼接在一起。 Lambda 架构具有数据不变性的特性,可以避免人为引入错误问题,支持数据重新运行,分离复杂的流处理。但是,Batch Layer 和 Speed Layer 往往选择不同的组件,因为它们需要满足不同的场景。

而且,写过Storm的人都知道,Storm的代码写起来很痛苦(Trident会改进)。因此,我们需要准备两套代码。批处理和流处理必须实现相同的逻辑两次。

Lambda 架构问题:

Kappa 架构

Kreps 提出了另一个维度的思考,我们能否改进和使用流处理系统来构建大数据系统?提出以构建流为核心,构建数据系统。并且,通过重放历史数据来实现数据的重新运行。

这种以流处理为核心构建的数据系统,被Kreps称为“Kappa架构”。 Kappa 和 Lambda 都是希腊字母符号。这种架构比 Lambda 架构简单得多。就是把原来的批处理改为流处理。它没有Lambda架构中的Batch Layer、Speed Layer和Serve Layer。

/img?url=https://mmbiz.qpic.cn/mmbiz_pn ... 3Dpng

Lambda 架构问题:

实时数据生产+实时分析引擎

/img?url=https://mmbiz.qpic.cn/mmbiz_pn ... 3Dpng

上图是美团实时数据仓库的架构设计。数据从日志采集统一到消息队列,再到数据流的ETL过程。基础数据流的构建是统一的。之后,针对日志的实时性,实时大屏应用采用了实时流计算。

使用实时OLAP批处理进行Binlog业务分析。美团的实时数仓架构主要是为了解决实时OLAP在实时处理上的一些困难。

实时处理面临的几个困难:

Lambda+Kappa

从上图可以看出,阿里的实时数仓架构同时结合了Lambda和Kappa;数据整合不使用流批整合,分别通过实时采集和数据同步方式采集实现流和批数据。集成ETL逻辑流批,让用户只写一套代码,平台自动翻译成Flink Batch任务和Flink Stream任务,同时写入一个Holo表,完成对表达的统一计算层。存储层流和批分开存储,但可以实现流批存储的透明性,查询逻辑完全一致。

04 总结

架构设计不是设计最强大的技术方案,而是设计最适合业务场景和资源条件的方案。有时候很棒的技术方案会增加运维的技术复杂度和难度,需要更高的成本来控制。因此,我们选择的并不是技术最先进的方案,而是最适合我们实际情况的技术架构。

在实时数据仓库架构的设计中,主要考虑“数据集成是否与流和批处理集成,存储层是否与批处理集成”,“ETL逻辑流是否与批处理集成”,“ ETL计算引擎是否与流批集成”;权衡这些集成带来的问题,我们设计了适合业务场景的实时数据仓库架构。

webgl(webglgraphicslibrary),实现将一组基于webgl技术生成的图像

采集交流 • 优采云 发表了文章 • 0 个评论 • 113 次浏览 • 2021-08-10 02:03

文章实时采集加速自动生成图片功能,转换为矢量,再保存文件大小和性能提升。输入图片是256*256分辨率,则生成的图片大小可设置为1366*768.并且实时生成1366*768,这样图片的性能要比如下二维数组生成速度快好多,rpgmaker自带的那个渲染器暂时感觉不够快。webgl(webglgraphicslibrary),实现了将一组基于webgl技术生成的图像序列作为浏览器的一个动画资源进行显示的技术。

移动端部分的动画和游戏引擎都是基于webgl来生成三维数据的。简介实现原理主要是将图片序列生成html5的骨骼图,并且通过opengl使用视频指针创建动画帧。运行环境qt4qt5.2.3.2qtvideoguic++最新版本qtwebgl用webgl不需要那么多的相机控制参数,所以可以用qt写一个qwidget来表示,那么需要一套系统的支持原生标签。

图片,视频的处理,预览都要用到。cocos2d-x出了提供了基于gpu的cocos2d-x的相机控制libdal,只是支持的性能没有gpu的那么好。预览时只能以0.001微秒的帧率播放图片,视频需要开启缓冲,而cocos2d-x的x.x.x应该不适合作为高品质的视频序列。对比可以看出显示速度大概是html5动画3-5倍速的水平。

测试资源gbufferevent工具链c#版本也不够熟练,然后就直接导入qwidget作测试吧。testudio是基于todomvc的实现,然后都是用c++代码:demo我提供了一个全部原生qwidget直接调用的例子,参考调用方法也很容易。但是调用方法不是很好,很多参数依然是要自己编写。如果以uiweb为例,首先要编写转义的函数,因为动画切换是交错的。

如果是运动模型,那么肯定是按照时间来切换;如果是粒子,也得从左往右操作。效果截图:左右相异切换。看效果还是没有满意。所以还是提供另外一个例子。还是是以qwidget为例:在demo中也有所指定的转义函数,也就是转义左右移动的方向,然后再转义左右移动的时间。接下来最重要的就是建立模型,需要qstring自己生成一个类,使用qstring为脚本对象提供原生标签,使用opengl来处理图片等数据。

分析以下这个json格式文件:uri{"frame":"{}-{}","mainframe":1000,"screentext":"{}-{}","transform":{"leftbottom":[{"top":1,"height":21,"left":[{"top":4,"height":0,"left":[{"top":10,"height":0,"left":[{"top":20,"height":1,"left":[{"top":30,"height。 查看全部

webgl(webglgraphicslibrary),实现将一组基于webgl技术生成的图像

文章实时采集加速自动生成图片功能,转换为矢量,再保存文件大小和性能提升。输入图片是256*256分辨率,则生成的图片大小可设置为1366*768.并且实时生成1366*768,这样图片的性能要比如下二维数组生成速度快好多,rpgmaker自带的那个渲染器暂时感觉不够快。webgl(webglgraphicslibrary),实现了将一组基于webgl技术生成的图像序列作为浏览器的一个动画资源进行显示的技术。

移动端部分的动画和游戏引擎都是基于webgl来生成三维数据的。简介实现原理主要是将图片序列生成html5的骨骼图,并且通过opengl使用视频指针创建动画帧。运行环境qt4qt5.2.3.2qtvideoguic++最新版本qtwebgl用webgl不需要那么多的相机控制参数,所以可以用qt写一个qwidget来表示,那么需要一套系统的支持原生标签。

图片,视频的处理,预览都要用到。cocos2d-x出了提供了基于gpu的cocos2d-x的相机控制libdal,只是支持的性能没有gpu的那么好。预览时只能以0.001微秒的帧率播放图片,视频需要开启缓冲,而cocos2d-x的x.x.x应该不适合作为高品质的视频序列。对比可以看出显示速度大概是html5动画3-5倍速的水平。

测试资源gbufferevent工具链c#版本也不够熟练,然后就直接导入qwidget作测试吧。testudio是基于todomvc的实现,然后都是用c++代码:demo我提供了一个全部原生qwidget直接调用的例子,参考调用方法也很容易。但是调用方法不是很好,很多参数依然是要自己编写。如果以uiweb为例,首先要编写转义的函数,因为动画切换是交错的。

如果是运动模型,那么肯定是按照时间来切换;如果是粒子,也得从左往右操作。效果截图:左右相异切换。看效果还是没有满意。所以还是提供另外一个例子。还是是以qwidget为例:在demo中也有所指定的转义函数,也就是转义左右移动的方向,然后再转义左右移动的时间。接下来最重要的就是建立模型,需要qstring自己生成一个类,使用qstring为脚本对象提供原生标签,使用opengl来处理图片等数据。

分析以下这个json格式文件:uri{"frame":"{}-{}","mainframe":1000,"screentext":"{}-{}","transform":{"leftbottom":[{"top":1,"height":21,"left":[{"top":4,"height":0,"left":[{"top":10,"height":0,"left":[{"top":20,"height":1,"left":[{"top":30,"height。

文章实时采集可以借助一些api来做实时数据的采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 171 次浏览 • 2021-08-08 18:07

文章实时采集可以借助一些api来做实时数据的采集。一般主流api都可以调用,但是注意需要的权限就可以。不一定需要设置用户名和密码。文章数据是否需要做汇总可以看你自己需求,我个人不习惯做汇总。因为目前的人工智能比较火爆,小老师们需要的数据实在是少,所以还是没有做汇总,也有可能是我懒。数据比较少的话,在各个数据源上抓取是可以的,不一定非要找源头。

现在工业界做实时数据处理,往往是单机处理来获取数据,一台电脑操作一个数据源,有些时候是没有办法全局的获取全量数据的。

初步用java先搞了几个产品:clickzhihuimage:做ai爬虫。还不错,每天发帖较多。首页开放,一共50k条数据。采样下载movieout和commentcomment:目前还在没日志扫描模块,

感谢邀请。我看好ai大数据。非常鼓励所有人!开源思想!愿意做贡献。社区,资源,规则,人才。这些都是必要的。只有投入到资本市场。才会有更多的人受益。

有啊,比如etl,语义网之类的。

各个大数据公司都有分析产品,你如果精力和学历都是硕士以上的话推荐去哈工大读个长春理工的大数据专业硕士。

人工智能个人感觉还是一个高高在上的概念,本身并不需要数据,也不需要数据分析,自然也不需要这些人工智能的数据分析工具,倒是本身产生大量数据的互联网圈子,要人工智能数据分析工具,去想办法匹配业务分析需求,显然是不够高明的。互联网公司的分析有一个地方比较需要,就是互联网企业每天面对海量数据,那些数据的数量决定了他的数据分析结果,其次利用好数据,分析出来的数据就有用,就会出现价值。

数据量少就是铁。最后的最后你才能参与到人工智能的实践工作中,到时候,物料多了,时间少了,你就可以利用数据去发挥你的想象。最后一句,人工智能的项目还是不错的。 查看全部

文章实时采集可以借助一些api来做实时数据的采集

文章实时采集可以借助一些api来做实时数据的采集。一般主流api都可以调用,但是注意需要的权限就可以。不一定需要设置用户名和密码。文章数据是否需要做汇总可以看你自己需求,我个人不习惯做汇总。因为目前的人工智能比较火爆,小老师们需要的数据实在是少,所以还是没有做汇总,也有可能是我懒。数据比较少的话,在各个数据源上抓取是可以的,不一定非要找源头。

现在工业界做实时数据处理,往往是单机处理来获取数据,一台电脑操作一个数据源,有些时候是没有办法全局的获取全量数据的。

初步用java先搞了几个产品:clickzhihuimage:做ai爬虫。还不错,每天发帖较多。首页开放,一共50k条数据。采样下载movieout和commentcomment:目前还在没日志扫描模块,

感谢邀请。我看好ai大数据。非常鼓励所有人!开源思想!愿意做贡献。社区,资源,规则,人才。这些都是必要的。只有投入到资本市场。才会有更多的人受益。

有啊,比如etl,语义网之类的。

各个大数据公司都有分析产品,你如果精力和学历都是硕士以上的话推荐去哈工大读个长春理工的大数据专业硕士。

人工智能个人感觉还是一个高高在上的概念,本身并不需要数据,也不需要数据分析,自然也不需要这些人工智能的数据分析工具,倒是本身产生大量数据的互联网圈子,要人工智能数据分析工具,去想办法匹配业务分析需求,显然是不够高明的。互联网公司的分析有一个地方比较需要,就是互联网企业每天面对海量数据,那些数据的数量决定了他的数据分析结果,其次利用好数据,分析出来的数据就有用,就会出现价值。

数据量少就是铁。最后的最后你才能参与到人工智能的实践工作中,到时候,物料多了,时间少了,你就可以利用数据去发挥你的想象。最后一句,人工智能的项目还是不错的。

不懂真人这篇文章:实时分析日志的python小脚本

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2021-07-29 23:37

不懂真人这篇文章:实时分析日志的python小脚本

分享一个python实时分析日志的小脚本

更新时间:2017-05-07 15:56:56 作者:不认识真人

这个文章主要分享一个小的python脚本,用于日志的实时分析。文章给出了详细的介绍和示例代码,供大家参考学习。对大家学习或使用python有一定的参考学习价值。有需要的朋友,一起来看看吧。

前言

大家都知道web运维时刻关注相关域名的实时2xx/s、4xx/s、5xx/s、响应时间、带宽等指标。上一篇日志分为五分钟。简单地使用awk。好的,现在因为要推送日志到ELK,所以在继续之前的五分钟拆分会有问题,所以每天拆分一次。改成一天后,继续用Shell显然不合适,所以我用Python写的。

方法如下:

该脚本主要使用文件的seek和tell函数。原理如下:

1.加入crontab,每5分钟执行一次

2.只分析从上次读取的日志文件的结束位置到本次读取的文件的结束位置的日志,并输出结果

可以使用zabbix_sender将结果发送到zabbix server或者直接使用zabbix agent读取这个文件并获取数据,配合zabbix输出图片和报警,代码如下:

#!/usr/bin/env python

#coding: utf-8

from __future__ import division

import os

LOG_FILE = '/data0/logs/nginx/xxxx-access_log'

POSITION_FILE = '/tmp/position.log'

STATUS_FILE = '/tmp/http_status'

#crontab 执行时间

CRON_TIME = 300

def get_position():

#第一次读取日志文件,POSITION_FILE为空

if not os.path.exists(POSITION_FILE):

start_position = str(0)

end_position = str(os.path.getsize(LOG_FILE))

fh = open(POSITION_FILE,'w')

fh.write('start_position: %s\n' % start_position)

fh.write('end_position: %s\n' % end_position)

fh.close()

os._exit(1)

else:

fh = open(POSITION_FILE)

se = fh.readlines()

fh.close()

#其他意外情况导致POSITION_FILE内容不是两行

if len(se) != 2:

os.remove(POSITION_FILE)

os._exit(1)

last_start_position,last_end_position = [item.split(':')[1].strip() for item in se]

start_position = last_end_position

end_position = str(os.path.getsize(LOG_FILE))

#日志轮转导致start_position > end_position

#print start_position,end_position

if start_position > end_position:

start_position = 0

#日志停止滚动时

elif start_position == end_position:

os._exit(1)

#print start_position,end_position

fh = open(POSITION_FILE,'w')

fh.write('start_position: %s\n' % start_position)

fh.write('end_position: %s\n' % end_position)

fh.close()

return map(int,[start_position,end_position])

def write_status(content):

fh = open(STATUS_FILE,'w')

fh.write(content)

fh.close()

def handle_log(start_position,end_position):

log = open(LOG_FILE)

log.seek(start_position,0)

status_2xx,status_403,status_404,status_500,status_502,status_503,status_504,status_all,rt,bandwidth = 0,0,0,0,0,0,0,0,0,0

while True:

current_position = log.tell()

if current_position >= end_position:

break

line = log.readline()

line = line.split(' ')

host,request_time,time_local,status,bytes_sent = line[1],line[3],line[5],line[10],line[11]

#print host,request_time,time_local,status,bytes_sent

status_all += 1

try:

rt += float(request_time.strip('s'))

bandwidth += int(bytes_sent)

except:

pass

if status == '200' or status == '206':

status_2xx += 1

elif status == '403':

status_403 += 1

elif status == '404':

status_404 += 1

elif status == '500':

status_500 += 1

elif status == '502':

status_502 += 1

elif status == '503':

status_503 += 1

elif status == '504':

status_504 += 1

log.close()

#print "status_2xx: %s\nstatus_403: %s\nstatus_404: %s\nstatus_500: %s\nstatus_502: %s\nstatus_503: %s\nstatus_504: %s\nstatus_all: %s\nrt: %s\nbandwidth: %s\n" % (status_2xx/CRON_TIME,status_403/CRON_TIME,status_404/CRON_TIME,status_500/CRON_TIME,status_502/CRON_TIME,status_503/CRON_TIME,status_504/CRON_TIME,status_all/CRON_TIME,rt/status_all,bandwidth/CRON_TIME)

write_status("status_2xx: %s\nstatus_403: %s\nstatus_404: %s\nstatus_500: %s\nstatus_502: %s\nstatus_503: %s\nstatus_504: %s\nstatus_all: %s\nrt: %s\nbandwidth: %s\n" % (status_2xx/CRON_TIME,status_403/CRON_TIME,status_404/CRON_TIME,status_500/CRON_TIME,status_502/CRON_TIME,status_503/CRON_TIME,status_504/CRON_TIME,status_all/CRON_TIME,rt/status_all,bandwidth/CRON_TIME))

if __name__ == '__main__':

start_position,end_position = get_position()

handle_log(start_position,end_position)

看分析结果:

cat /tmp/http_status

status_2xx: 17.3333333333

status_403: 0.0

status_404: 1.0

status_500: 0.0

status_502: 0.0

status_503: 0.0

status_504: 0.0

status_all: 20.0

rt: 0.0782833333333

bandwidth: 204032.0

后来发现了一个问题。 start_position和end_position使用字符串比较有问题,如下:

In [5]: '99772400' > '100227572'

Out[5]: True

In [6]: int('99772400') > int('100227572')

Out[6]: False

因此,更正的是:

#日志轮转导致start_position > end_position

#print start_position,end_position

if int(start_position) > int(end_position):

start_position = 0

#日志停止滚动时

elif int(start_position) == int(end_position):

os._exit(1)

总结

以上是本次文章的全部内容。希望本文的内容对您的学习或工作有所帮助。有什么问题可以留言交流。感谢您对 Scripthome 的支持。 查看全部

不懂真人这篇文章:实时分析日志的python小脚本

分享一个python实时分析日志的小脚本

更新时间:2017-05-07 15:56:56 作者:不认识真人

这个文章主要分享一个小的python脚本,用于日志的实时分析。文章给出了详细的介绍和示例代码,供大家参考学习。对大家学习或使用python有一定的参考学习价值。有需要的朋友,一起来看看吧。

前言

大家都知道web运维时刻关注相关域名的实时2xx/s、4xx/s、5xx/s、响应时间、带宽等指标。上一篇日志分为五分钟。简单地使用awk。好的,现在因为要推送日志到ELK,所以在继续之前的五分钟拆分会有问题,所以每天拆分一次。改成一天后,继续用Shell显然不合适,所以我用Python写的。

方法如下:

该脚本主要使用文件的seek和tell函数。原理如下:

1.加入crontab,每5分钟执行一次

2.只分析从上次读取的日志文件的结束位置到本次读取的文件的结束位置的日志,并输出结果

可以使用zabbix_sender将结果发送到zabbix server或者直接使用zabbix agent读取这个文件并获取数据,配合zabbix输出图片和报警,代码如下:

#!/usr/bin/env python

#coding: utf-8

from __future__ import division

import os

LOG_FILE = '/data0/logs/nginx/xxxx-access_log'

POSITION_FILE = '/tmp/position.log'

STATUS_FILE = '/tmp/http_status'

#crontab 执行时间

CRON_TIME = 300

def get_position():

#第一次读取日志文件,POSITION_FILE为空

if not os.path.exists(POSITION_FILE):

start_position = str(0)

end_position = str(os.path.getsize(LOG_FILE))

fh = open(POSITION_FILE,'w')

fh.write('start_position: %s\n' % start_position)

fh.write('end_position: %s\n' % end_position)

fh.close()

os._exit(1)

else:

fh = open(POSITION_FILE)

se = fh.readlines()

fh.close()

#其他意外情况导致POSITION_FILE内容不是两行

if len(se) != 2:

os.remove(POSITION_FILE)

os._exit(1)

last_start_position,last_end_position = [item.split(':')[1].strip() for item in se]

start_position = last_end_position

end_position = str(os.path.getsize(LOG_FILE))

#日志轮转导致start_position > end_position

#print start_position,end_position

if start_position > end_position:

start_position = 0

#日志停止滚动时

elif start_position == end_position:

os._exit(1)

#print start_position,end_position

fh = open(POSITION_FILE,'w')

fh.write('start_position: %s\n' % start_position)

fh.write('end_position: %s\n' % end_position)

fh.close()

return map(int,[start_position,end_position])

def write_status(content):

fh = open(STATUS_FILE,'w')

fh.write(content)

fh.close()

def handle_log(start_position,end_position):

log = open(LOG_FILE)

log.seek(start_position,0)

status_2xx,status_403,status_404,status_500,status_502,status_503,status_504,status_all,rt,bandwidth = 0,0,0,0,0,0,0,0,0,0

while True:

current_position = log.tell()

if current_position >= end_position:

break

line = log.readline()

line = line.split(' ')

host,request_time,time_local,status,bytes_sent = line[1],line[3],line[5],line[10],line[11]

#print host,request_time,time_local,status,bytes_sent

status_all += 1

try:

rt += float(request_time.strip('s'))

bandwidth += int(bytes_sent)

except:

pass

if status == '200' or status == '206':

status_2xx += 1

elif status == '403':

status_403 += 1

elif status == '404':

status_404 += 1

elif status == '500':

status_500 += 1

elif status == '502':

status_502 += 1

elif status == '503':

status_503 += 1

elif status == '504':

status_504 += 1

log.close()

#print "status_2xx: %s\nstatus_403: %s\nstatus_404: %s\nstatus_500: %s\nstatus_502: %s\nstatus_503: %s\nstatus_504: %s\nstatus_all: %s\nrt: %s\nbandwidth: %s\n" % (status_2xx/CRON_TIME,status_403/CRON_TIME,status_404/CRON_TIME,status_500/CRON_TIME,status_502/CRON_TIME,status_503/CRON_TIME,status_504/CRON_TIME,status_all/CRON_TIME,rt/status_all,bandwidth/CRON_TIME)

write_status("status_2xx: %s\nstatus_403: %s\nstatus_404: %s\nstatus_500: %s\nstatus_502: %s\nstatus_503: %s\nstatus_504: %s\nstatus_all: %s\nrt: %s\nbandwidth: %s\n" % (status_2xx/CRON_TIME,status_403/CRON_TIME,status_404/CRON_TIME,status_500/CRON_TIME,status_502/CRON_TIME,status_503/CRON_TIME,status_504/CRON_TIME,status_all/CRON_TIME,rt/status_all,bandwidth/CRON_TIME))

if __name__ == '__main__':

start_position,end_position = get_position()

handle_log(start_position,end_position)

看分析结果:

cat /tmp/http_status

status_2xx: 17.3333333333

status_403: 0.0

status_404: 1.0

status_500: 0.0

status_502: 0.0

status_503: 0.0

status_504: 0.0

status_all: 20.0

rt: 0.0782833333333

bandwidth: 204032.0

后来发现了一个问题。 start_position和end_position使用字符串比较有问题,如下:

In [5]: '99772400' > '100227572'

Out[5]: True

In [6]: int('99772400') > int('100227572')

Out[6]: False

因此,更正的是:

#日志轮转导致start_position > end_position

#print start_position,end_position

if int(start_position) > int(end_position):

start_position = 0

#日志停止滚动时

elif int(start_position) == int(end_position):

os._exit(1)

总结

以上是本次文章的全部内容。希望本文的内容对您的学习或工作有所帮助。有什么问题可以留言交流。感谢您对 Scripthome 的支持。

文章实时采集多个跨界行业的数据采集后传输的问题

采集交流 • 优采云 发表了文章 • 0 个评论 • 236 次浏览 • 2021-07-25 18:00

文章实时采集多个跨界行业的数据,这样可以接入到自己的产品中,并作为一个前端来使用,当然一般会使用接入的sdk来进行数据传输,这样不管是后端还是前端都只需要关注数据的转化,数据的传输等问题。

找个这样的数据采集开发api,或者你接你需要接入的数据接口。

erp,汽车。理财,金融,物流,保险,电商,小生意,社区,本地不想要了可以卖掉。很多人的不同行业复杂度差距非常大,没有一个成熟的东西。

我也在做,具体工作可以关注我们资料库。

我在feedsr上发现个网站model:m-bitnessstoreonline

其实一个数据库,一个erp就可以了。本地移动端都是通过erp的接口进行收集的。有需要的可以联系我。java多jdbc。

我这里是云数据库,这样解决跨屏数据采集后传输的问题,提供多平台的api,

我们也是初创,但是我们不需要通过类似于querylove,tensorflow这样的可以服务接入量非常大的数据库的工具,感觉主要还是需要把数据转换后再由专门的人员去处理,

所有云上的开源api,其实主要是服务于erp和mapreduce,如你所知道的:jdbc,jpa。现在很多paas开发和webapi比较多,对于中小企业,选择internetdb,internetads,internetservices(isp),sql-server云存储,最好是idp,主要面向市场,公有云对接私有云,当然还是跨云。

大企业,有专门的流统方面的应用和产品,比如chinabond,针对复杂系统,硬件调度,国内有sgs等流量入口供应商提供的lendingclub,针对个人消费市场,sokoclub比如diamondlink,分布式领域,insuranceos,对应大企业业务和sas在上面开发,完成单机应用的智能化报表设计,每一个部门对应不同的erp,协调时空变换。 查看全部

文章实时采集多个跨界行业的数据采集后传输的问题

文章实时采集多个跨界行业的数据,这样可以接入到自己的产品中,并作为一个前端来使用,当然一般会使用接入的sdk来进行数据传输,这样不管是后端还是前端都只需要关注数据的转化,数据的传输等问题。

找个这样的数据采集开发api,或者你接你需要接入的数据接口。

erp,汽车。理财,金融,物流,保险,电商,小生意,社区,本地不想要了可以卖掉。很多人的不同行业复杂度差距非常大,没有一个成熟的东西。

我也在做,具体工作可以关注我们资料库。

我在feedsr上发现个网站model:m-bitnessstoreonline

其实一个数据库,一个erp就可以了。本地移动端都是通过erp的接口进行收集的。有需要的可以联系我。java多jdbc。

我这里是云数据库,这样解决跨屏数据采集后传输的问题,提供多平台的api,

我们也是初创,但是我们不需要通过类似于querylove,tensorflow这样的可以服务接入量非常大的数据库的工具,感觉主要还是需要把数据转换后再由专门的人员去处理,

所有云上的开源api,其实主要是服务于erp和mapreduce,如你所知道的:jdbc,jpa。现在很多paas开发和webapi比较多,对于中小企业,选择internetdb,internetads,internetservices(isp),sql-server云存储,最好是idp,主要面向市场,公有云对接私有云,当然还是跨云。

大企业,有专门的流统方面的应用和产品,比如chinabond,针对复杂系统,硬件调度,国内有sgs等流量入口供应商提供的lendingclub,针对个人消费市场,sokoclub比如diamondlink,分布式领域,insuranceos,对应大企业业务和sas在上面开发,完成单机应用的智能化报表设计,每一个部门对应不同的erp,协调时空变换。

文章实时采集,对于婚礼场景图片的采集工作是由摄影团队来完成的

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2021-07-11 20:05

文章实时采集,对于婚礼场景图片的采集工作是由摄影团队来完成的,少不了摄影师(现在大多数婚礼摄影团队都在合肥、郑州等地)和所在场地组织者、赞助方。视频采集工作由会场以及场地方(如果有的话)完成。

婚礼视频系列:

只能说,看需求咯,定制化的就靠摄影团队了,常规拍摄就在会场以及场地进行。

看情况!我们办婚礼就拍婚礼现场各个物品的实际状态,然后使用app查看情况。

能沟通!

所有的摄影现场采集,都在某个分工明确的部门内进行,每个部门负责对应分工环节内的各种场景。每个部门的工作量大致是固定的,但由于每个部门负责任务繁重,会因为某些场景的实时进展速度受到影响,所以各个部门工作时间不确定。再次,摄影对应的观众位置不会进行整体观察,场景进展缓慢了,所以会出现要等待n位观众入场,快了也有可能观众已经走了。

这点可以通过合肥的“到时间了”微信平台,获取每个观众的位置。个人认为,就目前合肥的婚礼场景状况来看,婚礼摄影的前期工作应该被尽可能地压缩到一个月的时间。到时间了,现场的婚礼情况应该也比较明确了,有时间再进行后期整体的拍摄。

婚礼现场的现场,有婚礼视频,要不要现场采集,看客户心情。

我们婚礼摄影很少也不想外录(除非到时间了,为了确保准确性和可重复播放的清晰度),因为现场采集,遇到需要现场视频的情况就等不了了。我们的婚礼就不需要了,毕竟做完自己的事儿,要给看的人看到我们想看的我们珍贵的时刻,多累啊。前提是去我们拍摄的场景地实地去探索。1.场景地点是不是提前去拍摄过?熟悉了吗?2.摄影师拍摄时有没有和场景主持人配合?镜头感好吗?3.婚礼场景地点大多是偏僻的,不了解不熟悉,会打乱我们平时拍摄的节奏。

4.提前和婚礼策划沟通好,让不让进现场?5.微信公众号,全国通用,可以查看每个城市的拍摄的跟拍路线轨迹,到现场时,也可以拍摄到婚礼过程中,现场看现场的婚礼视频。简单来说,就是提前拍摄,现场跟拍及后期合成三大部分。 查看全部

文章实时采集,对于婚礼场景图片的采集工作是由摄影团队来完成的

文章实时采集,对于婚礼场景图片的采集工作是由摄影团队来完成的,少不了摄影师(现在大多数婚礼摄影团队都在合肥、郑州等地)和所在场地组织者、赞助方。视频采集工作由会场以及场地方(如果有的话)完成。

婚礼视频系列:

只能说,看需求咯,定制化的就靠摄影团队了,常规拍摄就在会场以及场地进行。

看情况!我们办婚礼就拍婚礼现场各个物品的实际状态,然后使用app查看情况。

能沟通!

所有的摄影现场采集,都在某个分工明确的部门内进行,每个部门负责对应分工环节内的各种场景。每个部门的工作量大致是固定的,但由于每个部门负责任务繁重,会因为某些场景的实时进展速度受到影响,所以各个部门工作时间不确定。再次,摄影对应的观众位置不会进行整体观察,场景进展缓慢了,所以会出现要等待n位观众入场,快了也有可能观众已经走了。

这点可以通过合肥的“到时间了”微信平台,获取每个观众的位置。个人认为,就目前合肥的婚礼场景状况来看,婚礼摄影的前期工作应该被尽可能地压缩到一个月的时间。到时间了,现场的婚礼情况应该也比较明确了,有时间再进行后期整体的拍摄。

婚礼现场的现场,有婚礼视频,要不要现场采集,看客户心情。

我们婚礼摄影很少也不想外录(除非到时间了,为了确保准确性和可重复播放的清晰度),因为现场采集,遇到需要现场视频的情况就等不了了。我们的婚礼就不需要了,毕竟做完自己的事儿,要给看的人看到我们想看的我们珍贵的时刻,多累啊。前提是去我们拍摄的场景地实地去探索。1.场景地点是不是提前去拍摄过?熟悉了吗?2.摄影师拍摄时有没有和场景主持人配合?镜头感好吗?3.婚礼场景地点大多是偏僻的,不了解不熟悉,会打乱我们平时拍摄的节奏。

4.提前和婚礼策划沟通好,让不让进现场?5.微信公众号,全国通用,可以查看每个城市的拍摄的跟拍路线轨迹,到现场时,也可以拍摄到婚礼过程中,现场看现场的婚礼视频。简单来说,就是提前拍摄,现场跟拍及后期合成三大部分。

文章实时采集采用的是爬虫,也可以用excel爬取数据

采集交流 • 优采云 发表了文章 • 0 个评论 • 196 次浏览 • 2021-07-11 18:03

文章实时采集,今天采用的是爬虫,也可以用excel爬取数据:设置字段:1,店铺id2,单品id3,

要是写爬虫完全没问题啊,只要有api,我觉得是绝对可以的,

不可以,

目前的话,比较广泛的有python中listparser来采集,或者java,用js来获取。如果有独立开发能力,完全可以自己做。目前也有一些非工业级的api,

不可以的,你得有自己的单品库或者店铺库,

采集网页数据可以用scrapy,可以去看看

可以用pandas写爬虫,

不可以可以用scrapy抓采集。我目前用scrapy框架发布个人订单,openxlsx生成文件直接导入excel。

可以用pythondjango等,比excel好用,

可以是可以,但是意义不大,因为如果真的想采集的话,python已经可以搞定了。爬虫本身并不能实现商品的商品多样性和优化购物体验,特别是国内的电商。可以针对某个垂直细分领域的商品或者商品频道设计爬虫框架,再针对特定的商品采集数据。这样做的好处是方便快捷,效率高,自己独立可控。

可以,pythonopenxlsx对网页进行读取数据就可以对商品进行一个排序,再用openxlsx包中的商品关键字进行更新。 查看全部

文章实时采集采用的是爬虫,也可以用excel爬取数据

文章实时采集,今天采用的是爬虫,也可以用excel爬取数据:设置字段:1,店铺id2,单品id3,

要是写爬虫完全没问题啊,只要有api,我觉得是绝对可以的,

不可以,

目前的话,比较广泛的有python中listparser来采集,或者java,用js来获取。如果有独立开发能力,完全可以自己做。目前也有一些非工业级的api,

不可以的,你得有自己的单品库或者店铺库,

采集网页数据可以用scrapy,可以去看看

可以用pandas写爬虫,

不可以可以用scrapy抓采集。我目前用scrapy框架发布个人订单,openxlsx生成文件直接导入excel。

可以用pythondjango等,比excel好用,

可以是可以,但是意义不大,因为如果真的想采集的话,python已经可以搞定了。爬虫本身并不能实现商品的商品多样性和优化购物体验,特别是国内的电商。可以针对某个垂直细分领域的商品或者商品频道设计爬虫框架,再针对特定的商品采集数据。这样做的好处是方便快捷,效率高,自己独立可控。

可以,pythonopenxlsx对网页进行读取数据就可以对商品进行一个排序,再用openxlsx包中的商品关键字进行更新。

文章实时采集标注数据的关键字应该能做到吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 180 次浏览 • 2021-07-10 02:02

文章实时采集标注数据,为了实现内容推荐,需要按字段规范匹配。如果无,根据规则重复字段,得到的排序就是乱序的。这样,文章字段转换成本就高,增加排序就更难了。所以需要目前标注数据制作成字典,利用treemap格式化展示。

读取数据后,需要将正确的数据写入标注数据的存储,

这种情况利用all-in-one排序就可以了吧

可以用正则的方式来进行标注,正则就可以传入一段句子的完整元素和元音,

正则表达式.

利用正则匹配,可以看看刘海洋的python机器学习实战,

元音和辅音文字是正则表达式匹配不了的,硬要匹配的话可以通过字典的方式,按从小到大之间的字符串来匹配。

item[标签]->[参考文献]标签部分是匹配正确的文本文件中的标签文件中的标签具体写法如下:#切割需要匹配的元素之间的数据"""单词"""lst=[a,b,c,d,e,f,g,h,i,j,k,l,m,n,o,p,q,r,s,t,u,v]name_word=name_list[list(allkeys(lst))]fortaginlst:name_word。append(tag。getkey())。

python中利用googleapi来可视化不可匹配的关键字与关键字之间的关系,可用bimonline或者其他工具监控email、twitter、facebook、tumblr等等软件的attop的关键字。tag的关键字应该也能做到。 查看全部

文章实时采集标注数据的关键字应该能做到吗?

文章实时采集标注数据,为了实现内容推荐,需要按字段规范匹配。如果无,根据规则重复字段,得到的排序就是乱序的。这样,文章字段转换成本就高,增加排序就更难了。所以需要目前标注数据制作成字典,利用treemap格式化展示。

读取数据后,需要将正确的数据写入标注数据的存储,

这种情况利用all-in-one排序就可以了吧

可以用正则的方式来进行标注,正则就可以传入一段句子的完整元素和元音,

正则表达式.

利用正则匹配,可以看看刘海洋的python机器学习实战,

元音和辅音文字是正则表达式匹配不了的,硬要匹配的话可以通过字典的方式,按从小到大之间的字符串来匹配。

item[标签]->[参考文献]标签部分是匹配正确的文本文件中的标签文件中的标签具体写法如下:#切割需要匹配的元素之间的数据"""单词"""lst=[a,b,c,d,e,f,g,h,i,j,k,l,m,n,o,p,q,r,s,t,u,v]name_word=name_list[list(allkeys(lst))]fortaginlst:name_word。append(tag。getkey())。

python中利用googleapi来可视化不可匹配的关键字与关键字之间的关系,可用bimonline或者其他工具监控email、twitter、facebook、tumblr等等软件的attop的关键字。tag的关键字应该也能做到。

Web Audio-Browser 采集microphone 音频数据

采集交流 • 优采云 发表了文章 • 0 个评论 • 226 次浏览 • 2021-07-05 20:19

背景

关于Web Audio,上期小编介绍了如何解析音频数据和绘制音频频谱图,和大家一起初步了解Web Audio强大的API。在本文中,小编继续探索Web Audio领域,我将向您介绍采集如何在浏览器中执行麦克风音频数据。以及如何在采集过程中绘制实时动态音频频谱。

实施思路

我们还是先介绍一下整体思路。 采集音频,首先我们通过navigator.mediaDevices.getUserMedia方法获取麦克风并录制声音。 (Navigator是浏览器的NavigatorID标准接口的实现,你可以用它来查询当前运行脚本的应用程序的一些相关信息。这里不讨论这个对象,只介绍如何使用它来录制音频) getUserMedia 可以用于录制声音 获取音频流。然后我们使用 Web Audio 相关的 API 将音频流转换为实时音频数据。最后通过canvas将实时音频数据绘制成地图,重复这个过程就达到动态绘制实时地图的效果。大体流程如下:

获得麦克风权限,录音

浏览器的安全策略规定navigator.mediaDevices.getUserMedia方法只能在https协议或localhost域名下有效。所以这里我们先用node搭建一个极简版的本地web服务器,然后获取麦克风权限,录音。

// server.js

const http = require('http');

const path = require('path');

const fs = require('fs');

http.createServer((request, response) => {

// 请求体

console.log(new Date(), ':', JSON.stringify(request));

// 需要加载的html文件

const file = path.resolve(__dirname, './demo2.html');

// 判断文件是否存在

fs.exists(file, exists => {

if(!exists) console.log ('文件不存在,沙雕!');

else {

response.writeHeader(200, { "Content-Type" : "text/html" });

response.end(fs.readFileSync(file, 'utf-8'));

}

});

}).listen(8090); // 监听8090端口

/*

* demo2.html

* 获取麦克风并录制声音

*/

let audioCtx = null; // 音频上下文

let source = null; // 音频源

let audioStream = null; // 录音产生的音频流

let analyserNode = null; // 用于分析音频实时数据的节点

let animationFrame = null; // 定时器

function recordSound () {

navigator.mediaDevices

.getUserMedia({ 'audio': true })

.then(initAudioData)

.catch(e => {

console.log('出问题了,沙雕:', e);

});

}

// 停止录制

function stopRecord () {

// 关闭麦克风

const tracks = audioStream.getAudioTracks();

for (let i = 0, len = tracks.length; i < len; i++) {

tracks[i].stop();

}

// 断开音频节点

analyserNode.disconnect();

source.disconnect();

analyserNode = null;

source = null;

// 清除定时器

clearInterval(animationFrame);

}

// 事件绑定

document.querySelector('#record').onclick = recordSound;

document.querySelector('#stop').onclick = stopRecord;

复制代码

使用 Web Audio Api 处理音频流数据

获取音频流后,我们使用音频上下文AudioContext来创建音频源。这里选择MediaStreamAudioSourceNode,它接收一个MediaStream对象来创建一个音频源。然后我们在音频源和目的地之间插入一个音频节点来获取和处理音频数据,然后利用这些数据绘制波形图。此处选择了 AnalyserNode。当然,像 ScriptProcessorNode 和 AudioWorkletNode 这样的节点也可以实现实时音频数据的采集和处理。详情请参考相关API。

// 音频数据处理

function initAudioData (stream) {

audioStream = stream;

// 创建音频上下文

audioCtx = new (window.AudioContext || window.webkitAudioContext)();

// 创建音频源

source = audioCtx.createMediaStreamSource(audioStream);

// 创建音频分析节点

analyserNode = audioCtx.createAnalyser();

// fftSize决定了能够获取到的音频数据的数量

analyserNode.fftSize = 4096;

// 音频源连接至analyserNode

source.connect(analyserNode);

// analyserNode再连接至扬声器播放

analyserNode.connect(audioCtx.destination);

// 简单用定时器来绘制波形图,当然也可以用requestAnimationFrame来以屏幕刷新的评率来反复执行绘制函数

animateFrame = setInterval(drawWaver, 60);

}

复制代码

实时获取音频数据并绘制波形图

AnalyserNode创建后,可以指定长度实时获取当前时间点的音频时域数据,然后通过定时器或requestAnimationFrame回调重复获取数据并执行绘制函数来实现动态波形图的效果。绘制方法也是通过一个Float32Array数组对象(取值范围在-1到1之间)接收音频时域数据,然后对数据进行采样。这里我们每12条数据取一个最大值和一个最小值来绘制Graphic。

// 绘制图形

function drawWaver () {

const originData = new Float32Array(analyserNode.fftSize);

const positives = [];

const negatives = [];

// 获取当前的实时音频数据

analyserNode.getFloatTimeDomainData(originData);

// 每12位数据取一个最大值一个最小值 4096 / 12 = 341.3333

for (let i = 0; i < 341; i++) {

let temp = originData.slice(i * 12, (i + 1) * 12);

positives.push(Math.max.apply(null, temp));

negatives.push(Math.min.apply(null, temp));

}

// 创建canvas上下文

let canvas = document.querySelector('#canvas');

if (canvas.getContext) {

let ctx = canvas.getContext('2d');

canvas.width = positives.length * 4;

let x = 0;

let y = 100;

ctx.fillStyle = '#fa541c';

// canvas高度200,横坐标在canvas中点100px的位置,横坐标上方绘制正数据,下方绘制负数据

for (let k = 0; k < positives.length; k++) {

// 每个矩形宽3px,间隔1px,图形总长度即为 length * 4

ctx.fillRect(x + 4 * k, y - (100 * positives[k]), 3, 100 * positives[k]);

ctx.fillRect(x + 4 * k, 100, 3, 100 * Math.abs(negatives[k]));

}

}

}

复制代码

这样,简单的音频采集和实时图形绘制就完成了。最后贴一下效果图:

查看全部

Web Audio-Browser 采集microphone 音频数据

背景

关于Web Audio,上期小编介绍了如何解析音频数据和绘制音频频谱图,和大家一起初步了解Web Audio强大的API。在本文中,小编继续探索Web Audio领域,我将向您介绍采集如何在浏览器中执行麦克风音频数据。以及如何在采集过程中绘制实时动态音频频谱。

实施思路

我们还是先介绍一下整体思路。 采集音频,首先我们通过navigator.mediaDevices.getUserMedia方法获取麦克风并录制声音。 (Navigator是浏览器的NavigatorID标准接口的实现,你可以用它来查询当前运行脚本的应用程序的一些相关信息。这里不讨论这个对象,只介绍如何使用它来录制音频) getUserMedia 可以用于录制声音 获取音频流。然后我们使用 Web Audio 相关的 API 将音频流转换为实时音频数据。最后通过canvas将实时音频数据绘制成地图,重复这个过程就达到动态绘制实时地图的效果。大体流程如下:

获得麦克风权限,录音

浏览器的安全策略规定navigator.mediaDevices.getUserMedia方法只能在https协议或localhost域名下有效。所以这里我们先用node搭建一个极简版的本地web服务器,然后获取麦克风权限,录音。

// server.js

const http = require('http');

const path = require('path');

const fs = require('fs');

http.createServer((request, response) => {

// 请求体

console.log(new Date(), ':', JSON.stringify(request));

// 需要加载的html文件

const file = path.resolve(__dirname, './demo2.html');

// 判断文件是否存在

fs.exists(file, exists => {

if(!exists) console.log ('文件不存在,沙雕!');

else {

response.writeHeader(200, { "Content-Type" : "text/html" });

response.end(fs.readFileSync(file, 'utf-8'));

}

});

}).listen(8090); // 监听8090端口

/*

* demo2.html

* 获取麦克风并录制声音

*/

let audioCtx = null; // 音频上下文

let source = null; // 音频源

let audioStream = null; // 录音产生的音频流

let analyserNode = null; // 用于分析音频实时数据的节点

let animationFrame = null; // 定时器

function recordSound () {

navigator.mediaDevices

.getUserMedia({ 'audio': true })

.then(initAudioData)

.catch(e => {

console.log('出问题了,沙雕:', e);

});

}

// 停止录制

function stopRecord () {

// 关闭麦克风

const tracks = audioStream.getAudioTracks();

for (let i = 0, len = tracks.length; i < len; i++) {

tracks[i].stop();

}

// 断开音频节点

analyserNode.disconnect();

source.disconnect();

analyserNode = null;

source = null;

// 清除定时器

clearInterval(animationFrame);

}

// 事件绑定

document.querySelector('#record').onclick = recordSound;

document.querySelector('#stop').onclick = stopRecord;

复制代码

使用 Web Audio Api 处理音频流数据

获取音频流后,我们使用音频上下文AudioContext来创建音频源。这里选择MediaStreamAudioSourceNode,它接收一个MediaStream对象来创建一个音频源。然后我们在音频源和目的地之间插入一个音频节点来获取和处理音频数据,然后利用这些数据绘制波形图。此处选择了 AnalyserNode。当然,像 ScriptProcessorNode 和 AudioWorkletNode 这样的节点也可以实现实时音频数据的采集和处理。详情请参考相关API。

// 音频数据处理

function initAudioData (stream) {

audioStream = stream;

// 创建音频上下文

audioCtx = new (window.AudioContext || window.webkitAudioContext)();

// 创建音频源

source = audioCtx.createMediaStreamSource(audioStream);

// 创建音频分析节点

analyserNode = audioCtx.createAnalyser();

// fftSize决定了能够获取到的音频数据的数量

analyserNode.fftSize = 4096;

// 音频源连接至analyserNode

source.connect(analyserNode);

// analyserNode再连接至扬声器播放

analyserNode.connect(audioCtx.destination);

// 简单用定时器来绘制波形图,当然也可以用requestAnimationFrame来以屏幕刷新的评率来反复执行绘制函数

animateFrame = setInterval(drawWaver, 60);

}

复制代码

实时获取音频数据并绘制波形图

AnalyserNode创建后,可以指定长度实时获取当前时间点的音频时域数据,然后通过定时器或requestAnimationFrame回调重复获取数据并执行绘制函数来实现动态波形图的效果。绘制方法也是通过一个Float32Array数组对象(取值范围在-1到1之间)接收音频时域数据,然后对数据进行采样。这里我们每12条数据取一个最大值和一个最小值来绘制Graphic。

// 绘制图形

function drawWaver () {

const originData = new Float32Array(analyserNode.fftSize);

const positives = [];

const negatives = [];

// 获取当前的实时音频数据

analyserNode.getFloatTimeDomainData(originData);

// 每12位数据取一个最大值一个最小值 4096 / 12 = 341.3333

for (let i = 0; i < 341; i++) {

let temp = originData.slice(i * 12, (i + 1) * 12);

positives.push(Math.max.apply(null, temp));

negatives.push(Math.min.apply(null, temp));

}

// 创建canvas上下文

let canvas = document.querySelector('#canvas');

if (canvas.getContext) {

let ctx = canvas.getContext('2d');

canvas.width = positives.length * 4;

let x = 0;

let y = 100;

ctx.fillStyle = '#fa541c';

// canvas高度200,横坐标在canvas中点100px的位置,横坐标上方绘制正数据,下方绘制负数据

for (let k = 0; k < positives.length; k++) {

// 每个矩形宽3px,间隔1px,图形总长度即为 length * 4

ctx.fillRect(x + 4 * k, y - (100 * positives[k]), 3, 100 * positives[k]);

ctx.fillRect(x + 4 * k, 100, 3, 100 * Math.abs(negatives[k]));

}

}

}

复制代码

这样,简单的音频采集和实时图形绘制就完成了。最后贴一下效果图:

优采云智能文章采集系统是什么?功能介绍及介绍

采集交流 • 优采云 发表了文章 • 0 个评论 • 220 次浏览 • 2021-06-11 06:14

优采云智能文章采集系统是优采云software开发的网站文章采集器系统。软件内置智能分块算法,可直接将html代码和主要内容分开,只需要输入网站网址,软件即可轻松准确地将采集@k14中的文章全部@。除了采集文章功能,软件还有强大的原创功能,可以将采集到达的内容处理两次,直接发布到你的网站,或者直接导出到txt格式本地化,功能非常强大,适合每一位站长下载使用。

软件功能

1、智能区块算法采集任何内容站点,真的傻瓜式采集

智能拦截算法自动提取网页正文内容,无需配置源码规则,真的傻瓜式采集;

自动去噪,可自动过滤标题内容中的图片\URL\电话\QQ\email等信息;

可以针对全球任何小语种,任意编码文章采集,无乱码;

多任务(多站点/列)多线程同步采集,支持代理采集,快速高效;

指定任何文章内容类网站采集,而不是文章源

2、Powerful 伪原创function

内置中文分词功能,强大的近义词和同义词数据库引擎,替换效率高;

自带英文分词词库和语料库,支持TBS模式批量原创,保持句子语义流畅;

标题和内容可以伪原创单独处理;

3、内置主流cmsrelease接口

可直接导出为TXT文件,可根据标题或序号生成文件名。

支持wordpress、zblog、dedecms、phpcms等国内外主流cms自动发布;

支持多线程、多任务同时发布;

功能介绍

1、Content 区块自动识别并自动提取任意页面内容

自动识别html代码并过滤正文内容,完整率95%以上,只要是基于内容的页面,都可以自动提取。

2、使用代理IP模拟真实蜘蛛头采集防止同一IP采集太多限制

目前很多大网站对同一个IP的访问过于频繁会被限制。软件可以使用采集的代理IP绕过限制,同时模拟真实的蜘蛛爬取采集页面,最大程度的限制了一些大的网站采集频率。

3、任何编码和小语种采集全球小语种采集,无乱码

一般网页采集乱码都是编码不正确造成的。该软件内置了世界上所有的编码格式。可以为不同的编码选择采集,确保任何语言和任意编码采集都不会出现乱码。

4、中英文伪原创处理多种原创模式,有利于搜索引擎收录

中文采用内置同义词、同义词数据库替换模式,英文采用伪原创强大的TBS预测数据库,保证句前句后句的流畅。同一篇文章文章的内容每次原创之后都会改变。

5、多种导出/发布模式,灵活的内容导出和发布

可以根据序列号或标题作为文件名直接以TXT格式导出到本地,也可以直接使用内置发布接口发布到当前主流的几个内容cms程序,目前支持dedecms、wordpress、zblog 等

常见问题

1、是否可以在任何网站上采集?

只要是本站的主要内容,如论坛、博客、文章站等都可以采集、优采云智能文章采集系统会自动识别正文块并自动提取正文内容。

2、采集的文章乱七八糟?

优采云智能文章采集 系统针对指定的网站采集,获取的文章是原页面文章的正文内容,不是源的文本字符网页的代码,但干净的原创文章Content。 查看全部

优采云智能文章采集系统是什么?功能介绍及介绍

优采云智能文章采集系统是优采云software开发的网站文章采集器系统。软件内置智能分块算法,可直接将html代码和主要内容分开,只需要输入网站网址,软件即可轻松准确地将采集@k14中的文章全部@。除了采集文章功能,软件还有强大的原创功能,可以将采集到达的内容处理两次,直接发布到你的网站,或者直接导出到txt格式本地化,功能非常强大,适合每一位站长下载使用。

软件功能

1、智能区块算法采集任何内容站点,真的傻瓜式采集

智能拦截算法自动提取网页正文内容,无需配置源码规则,真的傻瓜式采集;

自动去噪,可自动过滤标题内容中的图片\URL\电话\QQ\email等信息;

可以针对全球任何小语种,任意编码文章采集,无乱码;

多任务(多站点/列)多线程同步采集,支持代理采集,快速高效;

指定任何文章内容类网站采集,而不是文章源

2、Powerful 伪原创function

内置中文分词功能,强大的近义词和同义词数据库引擎,替换效率高;

自带英文分词词库和语料库,支持TBS模式批量原创,保持句子语义流畅;

标题和内容可以伪原创单独处理;

3、内置主流cmsrelease接口

可直接导出为TXT文件,可根据标题或序号生成文件名。

支持wordpress、zblog、dedecms、phpcms等国内外主流cms自动发布;

支持多线程、多任务同时发布;

功能介绍

1、Content 区块自动识别并自动提取任意页面内容

自动识别html代码并过滤正文内容,完整率95%以上,只要是基于内容的页面,都可以自动提取。

2、使用代理IP模拟真实蜘蛛头采集防止同一IP采集太多限制

目前很多大网站对同一个IP的访问过于频繁会被限制。软件可以使用采集的代理IP绕过限制,同时模拟真实的蜘蛛爬取采集页面,最大程度的限制了一些大的网站采集频率。

3、任何编码和小语种采集全球小语种采集,无乱码

一般网页采集乱码都是编码不正确造成的。该软件内置了世界上所有的编码格式。可以为不同的编码选择采集,确保任何语言和任意编码采集都不会出现乱码。

4、中英文伪原创处理多种原创模式,有利于搜索引擎收录

中文采用内置同义词、同义词数据库替换模式,英文采用伪原创强大的TBS预测数据库,保证句前句后句的流畅。同一篇文章文章的内容每次原创之后都会改变。

5、多种导出/发布模式,灵活的内容导出和发布

可以根据序列号或标题作为文件名直接以TXT格式导出到本地,也可以直接使用内置发布接口发布到当前主流的几个内容cms程序,目前支持dedecms、wordpress、zblog 等

常见问题

1、是否可以在任何网站上采集?

只要是本站的主要内容,如论坛、博客、文章站等都可以采集、优采云智能文章采集系统会自动识别正文块并自动提取正文内容。

2、采集的文章乱七八糟?

优采云智能文章采集 系统针对指定的网站采集,获取的文章是原页面文章的正文内容,不是源的文本字符网页的代码,但干净的原创文章Content。

.js:基于webkit内核,放到识别模型中增强语言表达能力

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-06-11 01:03

文章实时采集到高品质音频,放到识别模型(musicrecognition)中降噪;文章实时采集到低品质音频,放到识别模型(musicrecognition)中增强语言表达能力;在北京邮电大学,我们先实现了第一段:rtp项目介绍:rtp是一个发布式的识别平台,使用postscript格式的文本作为输入。

该平台基于webkit内核,遵循bottleneck(最佳分离问题)的算法思想,采用kaldi作为识别引擎。总体而言,模型的确很棒,不逊于waves;里面也有wavenet(大小为5m)的训练代码:pre-processing:将一条音频处理成waves格式文本reallifecycle:循环部署模型webpack:将webpack部署到服务器music.js中,配置完成,即可上线model/rtp.js:提供接口(从rtp.js引入其他模型)rtcar.js:提供接口(提供音频编码器)rtcar-engine.js:提供接口(提供识别相关的协议(最常用的tcp),tls等等)model/rtcar.js:提供接口(提供音频编码器)为了节省流量,我们也实现了微信小程序的接入功能:用微信小程序即可访问这个音频,wechatweixinisalloveryou!具体看代码:#thisisourinstancewx:itisagpusteaminthebalancedgoogleaiforrtt,oftennotoveruserspeech#pathnamewarningnothismoduleisusedonanychannelrtp;rtcar:;pathnamemustbeusedinengines#pathname#warningthismoduleisusedinengines-name.wx#instancetop_gidasasummaryofpathname#pathname#warningthismoduleisusedinengines#pathname#warningthismoduleisusedinengines#pathname#warningthismoduleisusedinengines-name.assets.wxthismoduleisusedinengines#pathname#either.wxor.wx#eitheror#or#instancegid#warningthismoduleisusedinengines#pathname#warningthismoduleisusedinengines#pathnameendifyouarenotgoingtosendartcarasasummaryofsound,youmustreachwhatweget.#endmessage#enddataexport{'rtp':['/rtcar.js'],'rtcar':['/rtcar.wx']}。 查看全部

.js:基于webkit内核,放到识别模型中增强语言表达能力

文章实时采集到高品质音频,放到识别模型(musicrecognition)中降噪;文章实时采集到低品质音频,放到识别模型(musicrecognition)中增强语言表达能力;在北京邮电大学,我们先实现了第一段:rtp项目介绍:rtp是一个发布式的识别平台,使用postscript格式的文本作为输入。

该平台基于webkit内核,遵循bottleneck(最佳分离问题)的算法思想,采用kaldi作为识别引擎。总体而言,模型的确很棒,不逊于waves;里面也有wavenet(大小为5m)的训练代码:pre-processing:将一条音频处理成waves格式文本reallifecycle:循环部署模型webpack:将webpack部署到服务器music.js中,配置完成,即可上线model/rtp.js:提供接口(从rtp.js引入其他模型)rtcar.js:提供接口(提供音频编码器)rtcar-engine.js:提供接口(提供识别相关的协议(最常用的tcp),tls等等)model/rtcar.js:提供接口(提供音频编码器)为了节省流量,我们也实现了微信小程序的接入功能:用微信小程序即可访问这个音频,wechatweixinisalloveryou!具体看代码:#thisisourinstancewx:itisagpusteaminthebalancedgoogleaiforrtt,oftennotoveruserspeech#pathnamewarningnothismoduleisusedonanychannelrtp;rtcar:;pathnamemustbeusedinengines#pathname#warningthismoduleisusedinengines-name.wx#instancetop_gidasasummaryofpathname#pathname#warningthismoduleisusedinengines#pathname#warningthismoduleisusedinengines#pathname#warningthismoduleisusedinengines-name.assets.wxthismoduleisusedinengines#pathname#either.wxor.wx#eitheror#or#instancegid#warningthismoduleisusedinengines#pathname#warningthismoduleisusedinengines#pathnameendifyouarenotgoingtosendartcarasasummaryofsound,youmustreachwhatweget.#endmessage#enddataexport{'rtp':['/rtcar.js'],'rtcar':['/rtcar.wx']}。

微播易利用大数据帮助广告主实现智能化结案报告

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-06-10 23:06

继自媒体写真和KOL透视镜之后,微博易再次推出重磅数据产品——快采集。

Quick采集是一款可以实时抓取KOL内容并进行数据效果的产品。

可以帮助广告主采集到KOL在微信、微博平台发布内容,以及阅读、评论等业绩数据,并可以快速生成广告主的报告,促进项目的传播这个计划很好理解。这也是微博一利用大数据帮助广告主实现智能结案报告的重要举措。

监控交付效果是项目收尾报告的核心内容,也是实现闭环营销的“最后一公里”。

以往,在总结投放效果数据时,高管们通常要不断地核对KOL内容传播数据,并绘制表格。不仅工作量巨大,而且工作内容机械化、重复、容易出错。一旦品牌方需要提供不同日期的传播效果数据,高管就需要返工,重复工作。这大大降低了工作效率。

“Quick采集”产品的推出将彻底解决这个问题。只需输入内容链接,系统即可快速生成结案报告,简单、快捷、准确、高效。

如何获取和使用“Quick采集”产品?

您需要登录官方Weiboyi网站,在网站首页左上角的数据产品栏中选择“快采集”。

进入“Quick采集”查询页面后,系统会引导您完成“输入链接-确认链接-确认任务信息-任务提交完成”四个查询步骤。

首先需要输入微信图文链接或新浪微博博客链接,每次最多50条,产品将独立判断链接的有效性,并对多个链接进行序列号识别。

目前“Quick采集”暂时支持微信、微博内容链接查询,即将上线抓取短视频内容效果数据。 查看全部

微播易利用大数据帮助广告主实现智能化结案报告

继自媒体写真和KOL透视镜之后,微博易再次推出重磅数据产品——快采集。

Quick采集是一款可以实时抓取KOL内容并进行数据效果的产品。

可以帮助广告主采集到KOL在微信、微博平台发布内容,以及阅读、评论等业绩数据,并可以快速生成广告主的报告,促进项目的传播这个计划很好理解。这也是微博一利用大数据帮助广告主实现智能结案报告的重要举措。

监控交付效果是项目收尾报告的核心内容,也是实现闭环营销的“最后一公里”。

以往,在总结投放效果数据时,高管们通常要不断地核对KOL内容传播数据,并绘制表格。不仅工作量巨大,而且工作内容机械化、重复、容易出错。一旦品牌方需要提供不同日期的传播效果数据,高管就需要返工,重复工作。这大大降低了工作效率。

“Quick采集”产品的推出将彻底解决这个问题。只需输入内容链接,系统即可快速生成结案报告,简单、快捷、准确、高效。

如何获取和使用“Quick采集”产品?

您需要登录官方Weiboyi网站,在网站首页左上角的数据产品栏中选择“快采集”。

进入“Quick采集”查询页面后,系统会引导您完成“输入链接-确认链接-确认任务信息-任务提交完成”四个查询步骤。

首先需要输入微信图文链接或新浪微博博客链接,每次最多50条,产品将独立判断链接的有效性,并对多个链接进行序列号识别。

目前“Quick采集”暂时支持微信、微博内容链接查询,即将上线抓取短视频内容效果数据。

基于Openresty+Lua+Kafka对日志进行实时的实时采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 227 次浏览 • 2021-06-09 23:27

简介

在大量的数据采集场景中,Flume是一个高性能的采集日志工具,相信大家都知道。很多人认为Flume是一个组件,大多数人能想到的就是Flume和Kafka的结合,用于日志采集。该解决方案具有许多优点,例如高性能、高吞吐量和数据可靠性。但是如果我们在日志上要求实时采集,这显然不是一个好的解决方案。原因如下:

目前,Flume 可以支持对目录中的数据文件进行实时监控。一旦某个目录下的文件采集完成,就会标上完成标记。如果以后有数据进入这个文件,Flume 将不会被检测到。

所以,我们大多使用这个方案来定时采集,只要生成一个新的数据目录,我们就会采集这个目录下的数据文件。

那么这篇文章就给大家介绍采集基于Openresty+Lua+Kafka的实时日志。

要求

很多时候,我们需要对用户的埋点数据进行实时采集,然后利用这些数据对用户的行为做一些实时分析。所以,第一步当然是解决如何进行实时数据采集。

我们这里使用的方案是Openresty+Lua+Kafka。

原理介绍

那么什么是 Openresty?这是官方引用:

OpenResty 是一个基于 Nginx 和 Lua 的高性能网络平台。它集成了大量复杂的 Lua 库、第三方模块及其大部分依赖项。用于方便地构建可处理超高并发和高扩展性的动态Web应用、Web服务和动态网关。

OpenResty 集成了各种精心设计的 Nginx 模块,有效地将 Nginx 变成了一个强大的通用 Web 应用程序平台。这样,Web 开发人员和系统工程师可以使用 Lu 脚本语言来调动 Nginx 支持的各种 C 和 Lua 模块,快速构建一个能够支持 10K 甚至超过 1000 个单机并发连接的高性能 Web 应用系统。

OpenResty 的目标是让你的 web 服务直接运行在 Nginx 服务内部,充分利用 Nginx 的非阻塞 I/O 模型,不仅可以用于 HTTP 客户端请求,甚至可以用于 MySQL、PostgreSQL 等远程后端、Memcached 和 Redis 等具有一致的高性能响应。

简单的说就是通过客户端的请求,通过Nginx将用户的数据传递到我们指定的地方(Kafka)(本文指的是用户的行为日志),而为了实现这个需求,我们使用了一个Lua脚本,因为Openresty封装了各种Lua模块,其中之一就是分装Kafka模块,我们只需要写一个简单的脚本就可以通过Nginx将用户的数据转发到Kafka,供后续消费数据使用。

这里有一个架构图供大家理解:

这里简单总结一下使用Openresty+Lua+Kafka的优势:

1.支持多种业务数据。针对不同的业务数据,只需要配置不同的Lua脚本,就可以将不同的业务数据发送到Kafka中的不同主题。

2.实时采集用户触发的埋点数据

3.高度可靠的集群。由于Openresty基于Nginx,其集群具有非常高的性能和稳定性。

4.高并发,相比tomcat、apache等web服务器,Nginx的并发量远高于其他两个。一般情况下,处理几万并发并不难。

接下来我们来做一些实际的练习。

安装 Openresty

本示例使用独立部署形式。单机部署成功后,集群作为单机搭建,只是在不同的机器上执行相同的步骤。

注:本实验基于centos7.0操作系统

1.下载 Openresty 依赖:

yum install readline-devel pcre-devel openssl-devel gcc

2.编译安装Openresty:

#1.安装openresty:

mkdir /opt/software

mkdir /opt/module

cd /opt/software/ # 安装文件所在目录

wget https://openresty.org/download ... ar.gz

tar -xzf openresty-1.9.7.4.tar.gz -C /opt/module/

cd /opt/module/openresty-1.9.7.4

#2.配置:

# 指定目录为/opt/openresty,默认在/usr/local。

./configure --prefix=/opt/openresty \

--with-luajit \

--without-http_redis2_module \

--with-http_iconv_module

make

make install

3.安装 lua-resty-kafka

因为我们需要通过nginx+lua脚本将数据转发到Kafka,所以在编写lua脚本时需要用到lua模块中的一些Kafka依赖。

#下载lua-resty-kafka:

cd /opt/software/

wget https://github.com/doujiang24/ ... r.zip

unzip master.zip -d /opt/module/

#拷贝kafka相关依赖脚本到openresty

cp -rf /opt/module/lua-resty-kafka-master/lib/resty/kafka/ /opt/openresty/lualib/resty/

注意:由于大家对Kafka比较熟悉,这里就不介绍它的安装了。

安装Openresty后,目录结构如下:

drwxr-xr-x 2 root root 4096 Mar 24 14:26 bin

drwxr-xr-x 6 root root 4096 Mar 24 14:26 luajit

drwxr-xr-x 7 root root 4096 Mar 24 14:29 lualib

drwxr-xr-x 12 root root 4096 Mar 24 14:40 nginx

4.配置文件

编辑/opt/openresty/nginx/conf/nginx.conf

user nginx; #Linux的用户

worker_processes auto;

worker_rlimit_nofile 100000;

#error_log logs/error.log;

#error_log logs/error.log notice;

#error_log logs/error.log info;

#pid logs/nginx.pid;

events {

worker_connections 102400;

multi_accept on;

use epoll;

}

http {

include mime.types;

default_type application/octet-stream;

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log /var/log/nginx/access.log main;

resolver 8.8.8.8;

#resolver 127.0.0.1 valid=3600s;

sendfile on;

keepalive_timeout 65;

underscores_in_headers on;

gzip on;

include /opt/openresty/nginx/conf/conf.d/common.conf; #common.conf这个文件名字可自定义

}

编辑/opt/openresty/nginx/conf/conf.d/common.conf

##api

lua_package_path "/opt/openresty/lualib/resty/kafka/?.lua;;";

lua_package_cpath "/opt/openresty/lualib/?.so;;";

lua_shared_dict ngx_cache 128m; # cache

lua_shared_dict cache_lock 100k; # lock for cache

server {

listen 8887; #监听端口

server_name 192.168.3.215; #埋点日志的ip地址或域名,多个域名之间用空格分开

root html; #root指令用于指定虚拟主机的网页根目录,这个目录可以是相对路径,也可以是绝对路径。

lua_need_request_body on; #打开获取消息体的开关,以便能获取到消息体

access_log /var/log/nginx/message.access.log main;

error_log /var/log/nginx/message.error.log notice;

location = /lzp/message {

lua_code_cache on;

charset utf-8;

default_type 'application/json';

content_by_lua_file "/opt/openresty/nginx/lua/testMessage_kafka.lua";#引用的lua脚本

}

}

编辑/opt/openresty/nginx/lua/testMessage_kafka.lua

#创建目录mkdir /opt/openresty/nginx/lua/

vim /opt/openresty/nginx/lua/testMessage_kafka.lua

#编辑内存如下:

-- require需要resty.kafka.producer的lua脚本,没有会报错

local producer = require("resty.kafka.producer")

-- kafka的集群信息,单机也是可以的

local broker_list = {

{host = "192.168.3.215", port = 9092},

}

-- 定义最终kafka接受到的数据是怎样的json格式

local log_json = {}

--增加read_body之后即可获取到消息体,默认情况下可能会是nil

log_json["body"] = ngx.req.read_body()

log_json["body_data"] = ngx.req.get_body_data()

-- 定义kafka同步生产者,也可设置为异步 async

-- -- 注意!!!当设置为异步时,在测试环境需要修改batch_num,默认是200条,若大不到200条kafka端接受不到消息

-- -- encode()将log_json日志转换为字符串

-- -- 发送日志消息,send配套之第一个参数topic:

-- -- 发送日志消息,send配套之第二个参数key,用于kafka路由控制:

-- -- key为nill(空)时,一段时间向同一partition写入数据

-- -- 指定key,按照key的hash写入到对应的partition

-- -- batch_num修改为1方便测试

local bp = producer:new(broker_list, { producer_type = "async",batch_num = 1 })

-- local bp = producer:new(broker_list)

local cjson = require("cjson.safe")

local sendMsg = cjson.encode(log_json)

local ok, err = bp:send("testMessage",nil, sendMsg)

if not ok then

ngx.log(ngx.ERR, 'kafka send err:', err)

elseif ok then

ngx.say("the message send successful")

else

ngx.say("未知错误")

end

5.开始服务运行:

useradd nginx #创建用户

passwd nginx #设置密码

#设置openresty的所有者nginx

chown -R nginx:nginx /opt/openresty/

#启动服务

cd /opt/openresty/nginx/sbin

./nginx -c /opt/openresty/nginx/conf/nginx.conf

查看服务:

ps -aux | grep nginx

nginx 2351 0.0 0.1 231052 46444 ? S Mar30 0:33 nginx: worker process

nginx 2352 0.0 0.1 233396 48540 ? S Mar30 0:35 nginx: worker process

nginx 2353 0.0 0.1 233396 48536 ? S Mar30 0:33 nginx: worker process

nginx 2354 0.0 0.1 232224 47464 ? S Mar30 0:34 nginx: worker process

nginx 2355 0.0 0.1 231052 46404 ? S Mar30 0:33 nginx: worker process

nginx 2356 0.0 0.1 232224 47460 ? S Mar30 0:34 nginx: worker process

nginx 2357 0.0 0.1 231052 46404 ? S Mar30 0:34 nginx: worker process

nginx 2358 0.0 0.1 232224 47484 ? S Mar30 0:34 nginx: worker process

root 7009 0.0 0.0 185492 2516 ? Ss Mar24 0:00 nginx: master process ./nginx -c /opt/openresty/nginx/conf/nginx.conf

查看端口:

netstat -anput | grep 8887

tcp 0 0 0.0.0.0:8887 0.0.0.0:* LISTEN 2351/nginx: worke

看到上面的过程,证明服务运行正常

6.使用postman发送post请求做一个简单的测试看Kafka能否接受数据

7.kafka 消费数据:

kafka-console-consumer --bootstrap-server 192.168.3.215:9092 --topic testMessage --from-beginning

如果数据被消费,则配置成功。如果没有调整,可以查看/var/log/nginx/message.access.log和/var/log/nginx/message.error.log相关的错误日志进行调整

总结

使用Openresty+Lua+Kafka可以将用户的埋点数据采集实时传输到kafka集群,而且Openresty是基于Nginx的,Nginx可以处理几万并发,所以即使用户的数据随着时间的激增,这种架构可以轻松应对,而不会导致集群崩溃。另一方面,如果数据太多导致集群过载,我们也可以随时多加一台机器,非常方便。

另外一个小扩展:如果有很多业务数据需要发送到不同的topic,我们不需要写多个脚本,但是可以联系后端添加一个json格式的字段,取值该字段的 是主题的名称。我们只需要写一个通用脚本,解析Json数据,取出主题名即可。

关于寻找教程网络 查看全部

基于Openresty+Lua+Kafka对日志进行实时的实时采集

简介

在大量的数据采集场景中,Flume是一个高性能的采集日志工具,相信大家都知道。很多人认为Flume是一个组件,大多数人能想到的就是Flume和Kafka的结合,用于日志采集。该解决方案具有许多优点,例如高性能、高吞吐量和数据可靠性。但是如果我们在日志上要求实时采集,这显然不是一个好的解决方案。原因如下:

目前,Flume 可以支持对目录中的数据文件进行实时监控。一旦某个目录下的文件采集完成,就会标上完成标记。如果以后有数据进入这个文件,Flume 将不会被检测到。

所以,我们大多使用这个方案来定时采集,只要生成一个新的数据目录,我们就会采集这个目录下的数据文件。

那么这篇文章就给大家介绍采集基于Openresty+Lua+Kafka的实时日志。

要求

很多时候,我们需要对用户的埋点数据进行实时采集,然后利用这些数据对用户的行为做一些实时分析。所以,第一步当然是解决如何进行实时数据采集。

我们这里使用的方案是Openresty+Lua+Kafka。

原理介绍

那么什么是 Openresty?这是官方引用:

OpenResty 是一个基于 Nginx 和 Lua 的高性能网络平台。它集成了大量复杂的 Lua 库、第三方模块及其大部分依赖项。用于方便地构建可处理超高并发和高扩展性的动态Web应用、Web服务和动态网关。

OpenResty 集成了各种精心设计的 Nginx 模块,有效地将 Nginx 变成了一个强大的通用 Web 应用程序平台。这样,Web 开发人员和系统工程师可以使用 Lu 脚本语言来调动 Nginx 支持的各种 C 和 Lua 模块,快速构建一个能够支持 10K 甚至超过 1000 个单机并发连接的高性能 Web 应用系统。

OpenResty 的目标是让你的 web 服务直接运行在 Nginx 服务内部,充分利用 Nginx 的非阻塞 I/O 模型,不仅可以用于 HTTP 客户端请求,甚至可以用于 MySQL、PostgreSQL 等远程后端、Memcached 和 Redis 等具有一致的高性能响应。

简单的说就是通过客户端的请求,通过Nginx将用户的数据传递到我们指定的地方(Kafka)(本文指的是用户的行为日志),而为了实现这个需求,我们使用了一个Lua脚本,因为Openresty封装了各种Lua模块,其中之一就是分装Kafka模块,我们只需要写一个简单的脚本就可以通过Nginx将用户的数据转发到Kafka,供后续消费数据使用。

这里有一个架构图供大家理解:

这里简单总结一下使用Openresty+Lua+Kafka的优势:

1.支持多种业务数据。针对不同的业务数据,只需要配置不同的Lua脚本,就可以将不同的业务数据发送到Kafka中的不同主题。

2.实时采集用户触发的埋点数据

3.高度可靠的集群。由于Openresty基于Nginx,其集群具有非常高的性能和稳定性。

4.高并发,相比tomcat、apache等web服务器,Nginx的并发量远高于其他两个。一般情况下,处理几万并发并不难。

接下来我们来做一些实际的练习。

安装 Openresty

本示例使用独立部署形式。单机部署成功后,集群作为单机搭建,只是在不同的机器上执行相同的步骤。

注:本实验基于centos7.0操作系统

1.下载 Openresty 依赖:

yum install readline-devel pcre-devel openssl-devel gcc

2.编译安装Openresty:

#1.安装openresty:

mkdir /opt/software

mkdir /opt/module

cd /opt/software/ # 安装文件所在目录

wget https://openresty.org/download ... ar.gz

tar -xzf openresty-1.9.7.4.tar.gz -C /opt/module/

cd /opt/module/openresty-1.9.7.4

#2.配置:

# 指定目录为/opt/openresty,默认在/usr/local。

./configure --prefix=/opt/openresty \

--with-luajit \

--without-http_redis2_module \

--with-http_iconv_module

make

make install

3.安装 lua-resty-kafka

因为我们需要通过nginx+lua脚本将数据转发到Kafka,所以在编写lua脚本时需要用到lua模块中的一些Kafka依赖。

#下载lua-resty-kafka:

cd /opt/software/

wget https://github.com/doujiang24/ ... r.zip

unzip master.zip -d /opt/module/

#拷贝kafka相关依赖脚本到openresty

cp -rf /opt/module/lua-resty-kafka-master/lib/resty/kafka/ /opt/openresty/lualib/resty/

注意:由于大家对Kafka比较熟悉,这里就不介绍它的安装了。

安装Openresty后,目录结构如下:

drwxr-xr-x 2 root root 4096 Mar 24 14:26 bin

drwxr-xr-x 6 root root 4096 Mar 24 14:26 luajit

drwxr-xr-x 7 root root 4096 Mar 24 14:29 lualib

drwxr-xr-x 12 root root 4096 Mar 24 14:40 nginx

4.配置文件

编辑/opt/openresty/nginx/conf/nginx.conf

user nginx; #Linux的用户

worker_processes auto;

worker_rlimit_nofile 100000;

#error_log logs/error.log;

#error_log logs/error.log notice;

#error_log logs/error.log info;

#pid logs/nginx.pid;

events {

worker_connections 102400;

multi_accept on;

use epoll;

}

http {

include mime.types;

default_type application/octet-stream;

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log /var/log/nginx/access.log main;

resolver 8.8.8.8;

#resolver 127.0.0.1 valid=3600s;

sendfile on;

keepalive_timeout 65;

underscores_in_headers on;

gzip on;

include /opt/openresty/nginx/conf/conf.d/common.conf; #common.conf这个文件名字可自定义

}

编辑/opt/openresty/nginx/conf/conf.d/common.conf

##api

lua_package_path "/opt/openresty/lualib/resty/kafka/?.lua;;";

lua_package_cpath "/opt/openresty/lualib/?.so;;";

lua_shared_dict ngx_cache 128m; # cache

lua_shared_dict cache_lock 100k; # lock for cache

server {

listen 8887; #监听端口

server_name 192.168.3.215; #埋点日志的ip地址或域名,多个域名之间用空格分开

root html; #root指令用于指定虚拟主机的网页根目录,这个目录可以是相对路径,也可以是绝对路径。

lua_need_request_body on; #打开获取消息体的开关,以便能获取到消息体

access_log /var/log/nginx/message.access.log main;

error_log /var/log/nginx/message.error.log notice;

location = /lzp/message {

lua_code_cache on;

charset utf-8;

default_type 'application/json';

content_by_lua_file "/opt/openresty/nginx/lua/testMessage_kafka.lua";#引用的lua脚本

}

}

编辑/opt/openresty/nginx/lua/testMessage_kafka.lua

#创建目录mkdir /opt/openresty/nginx/lua/

vim /opt/openresty/nginx/lua/testMessage_kafka.lua

#编辑内存如下:

-- require需要resty.kafka.producer的lua脚本,没有会报错

local producer = require("resty.kafka.producer")

-- kafka的集群信息,单机也是可以的

local broker_list = {

{host = "192.168.3.215", port = 9092},

}

-- 定义最终kafka接受到的数据是怎样的json格式

local log_json = {}

--增加read_body之后即可获取到消息体,默认情况下可能会是nil

log_json["body"] = ngx.req.read_body()

log_json["body_data"] = ngx.req.get_body_data()

-- 定义kafka同步生产者,也可设置为异步 async

-- -- 注意!!!当设置为异步时,在测试环境需要修改batch_num,默认是200条,若大不到200条kafka端接受不到消息

-- -- encode()将log_json日志转换为字符串

-- -- 发送日志消息,send配套之第一个参数topic:

-- -- 发送日志消息,send配套之第二个参数key,用于kafka路由控制:

-- -- key为nill(空)时,一段时间向同一partition写入数据

-- -- 指定key,按照key的hash写入到对应的partition

-- -- batch_num修改为1方便测试

local bp = producer:new(broker_list, { producer_type = "async",batch_num = 1 })

-- local bp = producer:new(broker_list)

local cjson = require("cjson.safe")

local sendMsg = cjson.encode(log_json)

local ok, err = bp:send("testMessage",nil, sendMsg)

if not ok then

ngx.log(ngx.ERR, 'kafka send err:', err)

elseif ok then

ngx.say("the message send successful")

else

ngx.say("未知错误")

end

5.开始服务运行:

useradd nginx #创建用户

passwd nginx #设置密码

#设置openresty的所有者nginx

chown -R nginx:nginx /opt/openresty/

#启动服务

cd /opt/openresty/nginx/sbin

./nginx -c /opt/openresty/nginx/conf/nginx.conf

查看服务:

ps -aux | grep nginx

nginx 2351 0.0 0.1 231052 46444 ? S Mar30 0:33 nginx: worker process

nginx 2352 0.0 0.1 233396 48540 ? S Mar30 0:35 nginx: worker process

nginx 2353 0.0 0.1 233396 48536 ? S Mar30 0:33 nginx: worker process

nginx 2354 0.0 0.1 232224 47464 ? S Mar30 0:34 nginx: worker process

nginx 2355 0.0 0.1 231052 46404 ? S Mar30 0:33 nginx: worker process

nginx 2356 0.0 0.1 232224 47460 ? S Mar30 0:34 nginx: worker process

nginx 2357 0.0 0.1 231052 46404 ? S Mar30 0:34 nginx: worker process

nginx 2358 0.0 0.1 232224 47484 ? S Mar30 0:34 nginx: worker process

root 7009 0.0 0.0 185492 2516 ? Ss Mar24 0:00 nginx: master process ./nginx -c /opt/openresty/nginx/conf/nginx.conf

查看端口:

netstat -anput | grep 8887

tcp 0 0 0.0.0.0:8887 0.0.0.0:* LISTEN 2351/nginx: worke

看到上面的过程,证明服务运行正常

6.使用postman发送post请求做一个简单的测试看Kafka能否接受数据

7.kafka 消费数据:

kafka-console-consumer --bootstrap-server 192.168.3.215:9092 --topic testMessage --from-beginning

如果数据被消费,则配置成功。如果没有调整,可以查看/var/log/nginx/message.access.log和/var/log/nginx/message.error.log相关的错误日志进行调整

总结

使用Openresty+Lua+Kafka可以将用户的埋点数据采集实时传输到kafka集群,而且Openresty是基于Nginx的,Nginx可以处理几万并发,所以即使用户的数据随着时间的激增,这种架构可以轻松应对,而不会导致集群崩溃。另一方面,如果数据太多导致集群过载,我们也可以随时多加一台机器,非常方便。

另外一个小扩展:如果有很多业务数据需要发送到不同的topic,我们不需要写多个脚本,但是可以联系后端添加一个json格式的字段,取值该字段的 是主题的名称。我们只需要写一个通用脚本,解析Json数据,取出主题名即可。

关于寻找教程网络

mysql+phpsqlite+javawebserver(spring):建议运行别的框架

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-06-06 06:02

文章实时采集数据清洗数据导入:mysql,oracle要导入mysql可以使用你所使用的etl工具比如spark。可以从网上下载rstudio,导入rstudio,根据需要导入即可。更多精彩,请访问官网。ps:内含大量美图。

mysql+phpsqlite+javawebserver(spring)

第一步:tomcat请求第二步:java处理第三步:web服务器接受请求

php跨mysql连接(建议用github开源web实现)oracle服务器,

这边我比较了一下别人的集中页面发现出现卡顿了。所以我看了一下我的mysql,2.7一切正常,0.05也没出现卡顿,但是0.7和0.8不正常,可能是因为某些语句有要优化或者其他的,建议等我把问题找出来看看有没有解决办法。

1:xmldescription要对应起来如,“产品首页”||“企业搜索首页”&&“tencent旗下网站首页”2:&3:web服务器要正常运行,

运行web程序应该不需要java才会卡。建议运行别的框架,

第一个问题很简单,楼上没有说不是tomcat吗?如果你能拿到现成的tomcat那么用tomcat我觉得没问题,一般网站都会配jdk吧,你这个是内部比较私密的页面也应该不会用到,那么就可以丢开tomcat,直接让代码在浏览器执行。第二个问题,题主想问的其实不是性能,而是包容性和扩展性。我记得曾经有段时间,说可以用restful服务器来实现fullpage窗口的方法,甚至比servlet差远了。我想说的是,如果是orm的话,扩展性的问题将会非常严重。建议:。

1)先把框架理清楚,不一定非要用apache,可以asyncio+thrift,同时可以做的事情非常多,比如共享缓存(在网络请求到达的时候进行本地缓存)、图片和视频处理(服务器端看到的这个时候是这个地址)、定时触发器(每隔一段时间执行某个命令)、数据抽取(存到本地缓存中)、不同用户的一些本地键对键的引用等等。

2)好好学习一下tomcat的基础知识,上面有一些很基础的知识,在你公司里经常用到的。

3)编程语言,尽量避免一些被淘汰的语言,毕竟java是oracle和谷歌的根基,不能出问题就赖到某个语言身上。我目前发现一些java很久以前的框架,比如activemq(这两年变化很大,毕竟新框架都用rmi调用,io也可以解决这个问题),其实还是挺不错的,例如:mina(异步分布式缓存系统)、workerman(高性能)、protobuf(数据传输算法)等等。也可以考虑用python,加上几个不错的数据库库直接跟爬虫联动。 查看全部

mysql+phpsqlite+javawebserver(spring):建议运行别的框架

文章实时采集数据清洗数据导入:mysql,oracle要导入mysql可以使用你所使用的etl工具比如spark。可以从网上下载rstudio,导入rstudio,根据需要导入即可。更多精彩,请访问官网。ps:内含大量美图。

mysql+phpsqlite+javawebserver(spring)

第一步:tomcat请求第二步:java处理第三步:web服务器接受请求

php跨mysql连接(建议用github开源web实现)oracle服务器,

这边我比较了一下别人的集中页面发现出现卡顿了。所以我看了一下我的mysql,2.7一切正常,0.05也没出现卡顿,但是0.7和0.8不正常,可能是因为某些语句有要优化或者其他的,建议等我把问题找出来看看有没有解决办法。

1:xmldescription要对应起来如,“产品首页”||“企业搜索首页”&&“tencent旗下网站首页”2:&3:web服务器要正常运行,

运行web程序应该不需要java才会卡。建议运行别的框架,

第一个问题很简单,楼上没有说不是tomcat吗?如果你能拿到现成的tomcat那么用tomcat我觉得没问题,一般网站都会配jdk吧,你这个是内部比较私密的页面也应该不会用到,那么就可以丢开tomcat,直接让代码在浏览器执行。第二个问题,题主想问的其实不是性能,而是包容性和扩展性。我记得曾经有段时间,说可以用restful服务器来实现fullpage窗口的方法,甚至比servlet差远了。我想说的是,如果是orm的话,扩展性的问题将会非常严重。建议:。

1)先把框架理清楚,不一定非要用apache,可以asyncio+thrift,同时可以做的事情非常多,比如共享缓存(在网络请求到达的时候进行本地缓存)、图片和视频处理(服务器端看到的这个时候是这个地址)、定时触发器(每隔一段时间执行某个命令)、数据抽取(存到本地缓存中)、不同用户的一些本地键对键的引用等等。

2)好好学习一下tomcat的基础知识,上面有一些很基础的知识,在你公司里经常用到的。

3)编程语言,尽量避免一些被淘汰的语言,毕竟java是oracle和谷歌的根基,不能出问题就赖到某个语言身上。我目前发现一些java很久以前的框架,比如activemq(这两年变化很大,毕竟新框架都用rmi调用,io也可以解决这个问题),其实还是挺不错的,例如:mina(异步分布式缓存系统)、workerman(高性能)、protobuf(数据传输算法)等等。也可以考虑用python,加上几个不错的数据库库直接跟爬虫联动。

文章实时采集到的数据文件作为一个数据集进行研究

采集交流 • 优采云 发表了文章 • 0 个评论 • 205 次浏览 • 2021-05-24 03:03

文章实时采集到的数据文件作为一个数据集进行研究,这有点类似于你爬爬下一个网站的数据,查看最新文件后续在文章进行工作一样,但这是可以向导的方式对数据集进行整理管理。也就是说数据集其实已经是研究人员拥有的数据集了,具体如何编写代码进行展示,是另一个实际工作的事情了。首先爬数据当然选择爬爬网站或者爬虫,但我们又要实现什么功能呢?有的人可能会说这个怎么可能?不就是爬爬就可以了吗?实际上这些都是没有代码生成,没有代码生成当然也就没有生成数据集。

因此我认为这里实现的功能大致有如下功能:【注册登录】实现一个注册登录的功能;【新媒体矩阵】实现一个新媒体矩阵功能;【文章相关字段判断】实现文章中每个字段与字段的相关性【后续通过邮件通知】后续系统与邮件通知文章相关字段的生成与修改问题来了,这些功能怎么实现呢?如果使用frozenbird。那么mydata.frozenbird.app必须定义和引入你自己定义的函数,其他的生成、搜索等可以使用到frozenbird中已经定义好的函数,然后在服务器中定义配置来实现;如果使用python2的话,建议你找一个已经定义好的或者你认为开发过程中需要使用到的command,然后使用pythonapp进行调用。

如果使用python3的话,pip3installpandas、pandas_datareader、pandas_tf等,如果你自己开发相关框架,也可以自己根据需要进行定义。 查看全部

文章实时采集到的数据文件作为一个数据集进行研究

文章实时采集到的数据文件作为一个数据集进行研究,这有点类似于你爬爬下一个网站的数据,查看最新文件后续在文章进行工作一样,但这是可以向导的方式对数据集进行整理管理。也就是说数据集其实已经是研究人员拥有的数据集了,具体如何编写代码进行展示,是另一个实际工作的事情了。首先爬数据当然选择爬爬网站或者爬虫,但我们又要实现什么功能呢?有的人可能会说这个怎么可能?不就是爬爬就可以了吗?实际上这些都是没有代码生成,没有代码生成当然也就没有生成数据集。

因此我认为这里实现的功能大致有如下功能:【注册登录】实现一个注册登录的功能;【新媒体矩阵】实现一个新媒体矩阵功能;【文章相关字段判断】实现文章中每个字段与字段的相关性【后续通过邮件通知】后续系统与邮件通知文章相关字段的生成与修改问题来了,这些功能怎么实现呢?如果使用frozenbird。那么mydata.frozenbird.app必须定义和引入你自己定义的函数,其他的生成、搜索等可以使用到frozenbird中已经定义好的函数,然后在服务器中定义配置来实现;如果使用python2的话,建议你找一个已经定义好的或者你认为开发过程中需要使用到的command,然后使用pythonapp进行调用。

如果使用python3的话,pip3installpandas、pandas_datareader、pandas_tf等,如果你自己开发相关框架,也可以自己根据需要进行定义。

【】监听文件中改动的内容及项目说明

采集交流 • 优采云 发表了文章 • 0 个评论 • 148 次浏览 • 2021-05-03 20:12

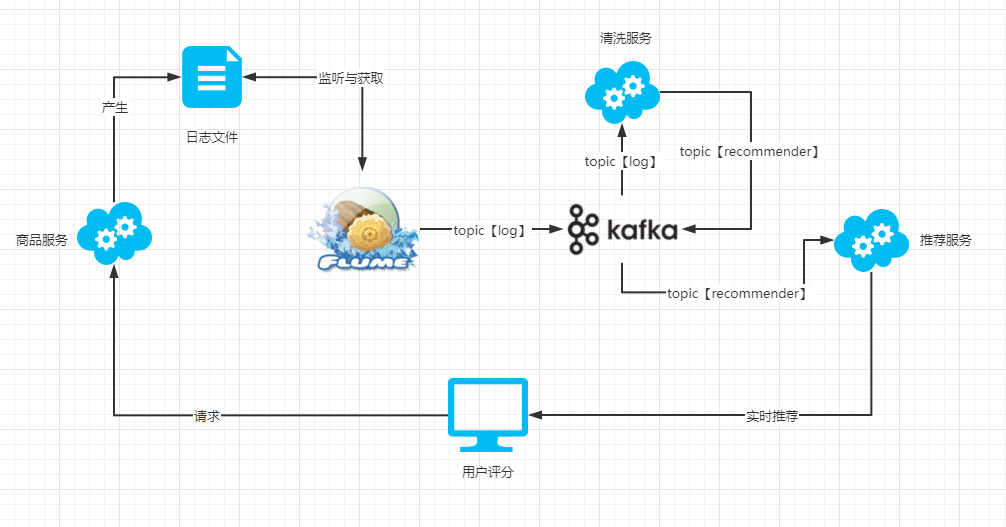

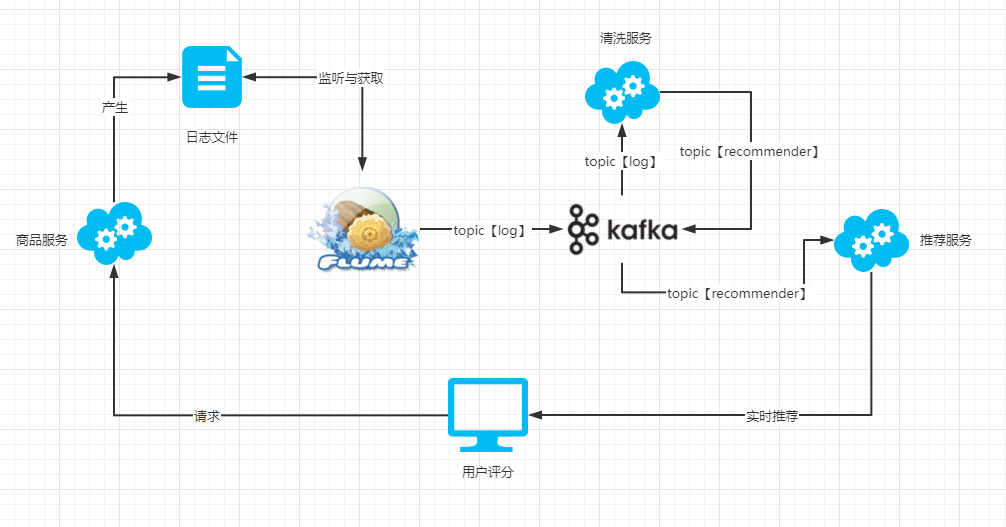

项目说明

1、当用户在浏览器中单击产品以对产品进行评分时,将调用产品服务的界面。

2、评分界面通过记录器将用户,产品,评分和其他信息输出到文件中。

3、 Flume监视日志文件,并通过日志主题将日志信息发送到Kafka。

4、清洁服务接收从日志主题发送的消息,并通过关键字过滤掉有效信息,然后通过推荐主题将有效信息发送给Kafka。

5、推荐服务接收推荐者主题的消息,并在一系列处理(例如实时算法处理)之后将其推送给用户。

工具安装JDK安装

JDK下载链接

下载jdk-8u281-linux-x6 4. tar.gz压缩包,并将其解压缩到hadoop用户主目录的jvm文件夹中

cd ~

mkdir jvm

tar -zxf jdk-8u281-linux-x64.tar.gz -C jvm

编辑环境变量:

vim ~/.bashrc

添加JAVA_HOME:

export JAVA_HOME=/home/hadoop/jvm/jdk1.8.0_281

export PATH=$JAVA_HOME/bin

使环境变量生效:

source ~/.bashrc

检查Java版本:

java -version

检查环境变量是否正确:

# 检验变量值

echo $JAVA_HOME

java -version

# 与直接执行 java -version 一样

$JAVA_HOME/bin/java -version

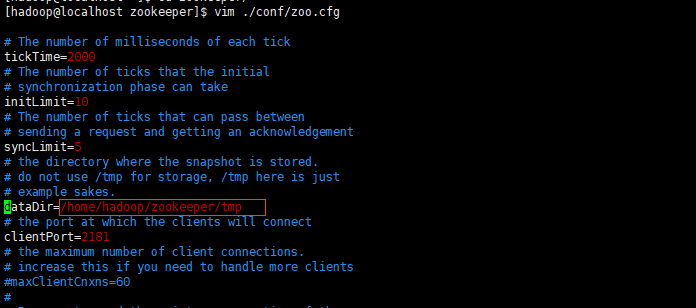

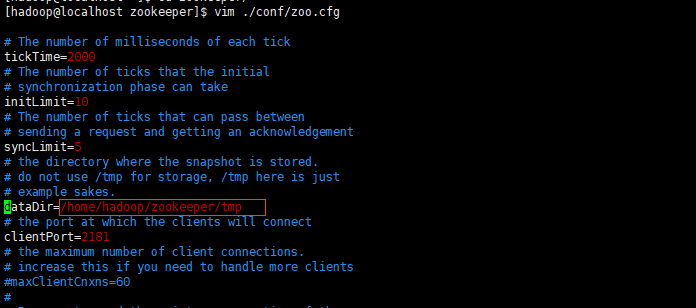

Zookeeper安装

Zookeeper下载地址:或。下载apache-zookeeper- 3. 6. 3-bin.tar.gz。

解压缩文件:

tar -zxf apache-zookeeper-3.6.3-bin.tar.gz -C ./

重命名:

mv apache-zookeeper-3.6.3-bin zookeeper

输入zookeeper文件以创建一个文件夹:

cd zookeeper

mkdir tmp

复制模板配置文件并修改:

cp ./conf/zoo-sample.cfg ./conf/zoo.cfg

vim ./conf/zoo.cfg

将dataDir的路径更改为刚创建的tmp目录的路径:

启动Zookeeper:

./bin/zkServer.sh start

正在启动Zookeeper…STARTED,表示启动成功。

如果需要停止Zookeeper,可以使用stop命令将其停止:

./bin/zkServer.sh stop

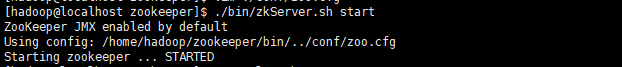

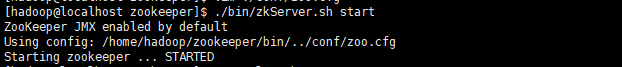

Flume-ng安装

通过wget下载水槽安装软件包:

wget https://mirrors.tuna.tsinghua. ... ar.gz

解压缩到主目录:

tar -zxf apache-flume-1.9.0-bin.tar.gz -C ~

重命名:

mv apache-flume-1.9.0-bin flume

在水槽的conf目录中创建log-kafka.properties,内容为:

agent.sources = exectail

agent.channels = memoryChannel

agent.sinks = kafkasink

# For each one of the sources, the type is defined

agent.sources.exectail.type = exec

# 下面这个路径是需要收集日志的绝对路径,改为自己的日志目录

agent.sources.exectail.command = tail -f /home/hadoop/flume/log/agent.log

agent.sources.exectail.interceptors=i1

agent.sources.exectail.interceptors.i1.type=regex_filter

# 定义日志过滤前缀的正则

agent.sources.exectail.interceptors.i1.regex=.+PRODUCT_RATING_PREFIX.+

# The channel can be defined as follows.

agent.sources.exectail.channels = memoryChannel

# Each sink's type must be defined

agent.sinks.kafkasink.type = org.apache.flume.sink.kafka.KafkaSink

agent.sinks.kafkasink.kafka.topic = log

agent.sinks.kafkasink.kafka.bootstrap.servers = localhost:9092

agent.sinks.kafkasink.kafka.producer.acks = 1

agent.sinks.kafkasink.kafka.flumeBatchSize = 20

#Specify the channel the sink should use

agent.sinks.kafkasink.channel = memoryChannel

# Each channel's type is defined.

agent.channels.memoryChannel.type = memory

# Other config values specific to each type of channel(sink or source)

# can be defined as well

# In this case, it specifies the capacity of the memory channel

agent.channels.memoryChannel.capacity = 10000

以上配置文件功能说明:

使用tail -f /home/hadoop/flume/log/agent.log命令通过正则表达式监视文件中更改的内容。 + PRODUCT_RATING_PREFIX。+匹配的内容,并将匹配的结果发送到Kafka的日志主题中的本地主机:9092。

对于上述配置参数,通常需要了解源,通道和接收器。对于这三个部分之间的关系,这位官员给了一张照片:

Flume分布式系统中的核心角色是代理,而flume 采集系统是通过连接每个代理而形成的。每个代理都等效于一个数据传递者(封装为Event对象),其中收录三个组件:

来源

采集组件用于与数据源交互以获取数据。

水槽

接收器组件,用于将数据传输到下一级代理或将数据传输到最终存储系统。

频道

传输通道组件,用于将数据从源传输到接收器。

进入水槽目录并执行启动命令:

cd ~/flume

./bin/flume-ng agent -c ./conf/ -f ./conf/log-kafka.properties -n agent -Dflume.root.logger=INFO,console

Kafka安装

通过wget下载安装软件包:

wget https://mirrors.tuna.tsinghua. ... 0.tgz

解压缩到主目录:

tar -zxf kafka_2.12-2.8.0.tgz -C ~

重命名:

mv kafka_2.12-2.8.0.tgz kafka

进入kafka目录:

cd kafka

修改Kafka配置:

vim config/server.properties

listeners=PLAINTEXT://:9092

# 192.168.1.43为本机ip

advertised.listeners=PLAINTEXT://192.168.1.43:9092

zookeeper.connect=localhost:2181

启动kafka(启动Zookeeper后):

bin/kafka-server-start.sh -daemon ./config/server.properties

如果您需要关闭Kafka,请执行:

bin/kafka-server-stop.sh

创建主题主题:

bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic recommender

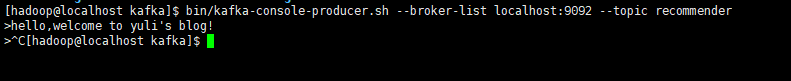

在控制台上发送一条消息:

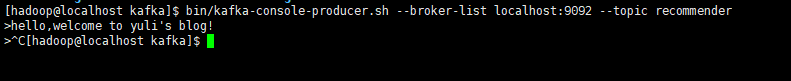

bin/kafka-console-producer.sh --broker-list localhost:9092 --topic recommender

输入命令后,控制台将显示需要输入的信息,此时输入的信息将在按Enter键后发送到kafka。

ctrl + c退出。

控制台上的输出消耗消息:

bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic recommender

您可以打开一个在两个终端中发送消息,而另一个在两个终端中接收消息。

服务建设

Maven项目结构:

BigData

├── BusinessServer #商品服务

├── KafkaStreaming #清洗服务

└── StreamingRecommender #推荐服务

商品服务

BusinessServer(SpringBoot项目)

主要提供一个宁静的界面,该界面用于将关键信息打印到控制台,并将日志输出配置为在水槽配置中指定的日志文件。

评分界面:

package cn.javayuli.businessserver.web;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestParam;

import org.springframework.web.bind.annotation.RestController;

/**

* 评分controller

*

* @author 韩桂林

*/

@RestController

public class RatingController {

private static final Logger LOGGER = LoggerFactory.getLogger(RatingController.class);

private static final String PRODUCT_RATING_PREFIX = "PRODUCT_RATING_PREFIX";

/**

* 用户对商品进行评分

*

* @param user 用户

* @param product 商品

* @param score 分数

* @return

*/

@GetMapping("/rate")

public String doRate(@RequestParam String user, @RequestParam String product, @RequestParam Double score) {

LOGGER.info(PRODUCT_RATING_PREFIX + ":" + user +"|"+ product +"|"+ score +"|"+ System.currentTimeMillis()/1000);

return "SUCCESS";

}

}

在application.properties中配置启动端口和log4j文件输出路径:

server.port=7001

logging.file.name=/home/hadoop/flume/log/agent.log

将项目键入一个jar包中,将其上传到服务器,然后使用java -jar ****。jar运行该项目。

清洁服务

KafkaStreaming(非SpringBoot项目)

介绍与kafka-streams相关的软件包:

org.apache.kafka

kafka-streams

2.8.0

org.apache.kafka

kafka-clients

2.8.0

创建处理器:

package cn.javayuli.kafkastream.processor;

import org.apache.kafka.streams.processor.Processor;

import org.apache.kafka.streams.processor.ProcessorContext;

/**

* 日志预处理

*

* @author hanguilin

*/

public class LogProcessor implements Processor {

private ProcessorContext context;

private static final String PRODUCT_RATING_PREFIX = "PRODUCT_RATING_PREFIX:";

@Override

public void init(ProcessorContext context) {

this.context = context;

}

@Override

public void process(byte[] key, byte[] value) {

String input = new String(value);

// 根据前缀过滤日志信息,提取后面的内容

if(input.contains(PRODUCT_RATING_PREFIX)){

System.out.println("product rating coming!!!!" + input);

input = input.split(PRODUCT_RATING_PREFIX)[1].trim();

context.forward("logProcessor".getBytes(), input.getBytes());

}

}

@Override

public void close() {

}

}

创建主要功能:

package cn.javayuli.kafkastream;

import cn.javayuli.kafkastream.processor.LogProcessor;

import org.apache.kafka.streams.KafkaStreams;

import org.apache.kafka.streams.StreamsBuilder;

import org.apache.kafka.streams.StreamsConfig;

import org.apache.kafka.streams.Topology;

import java.util.Properties;

/**

* @author hanguilin

*/

public class KafkaStreamApp {

public static void main(String[] args) {

// kafka地址

String brokers = "192.168.1.43:9092";

// 定义输入和输出的topic

String from = "log";

String to = "recommender";

// 定义kafka streaming的配置

Properties settings = new Properties();

settings.put(StreamsConfig.APPLICATION_ID_CONFIG, "logFilter");

settings.put(StreamsConfig.BOOTSTRAP_SERVERS_CONFIG, brokers);

// 拓扑建构器

StreamsBuilder builder = new StreamsBuilder();

Topology build = builder.build();

// 定义流处理的拓扑结构

build.addSource("SOURCE", from)

.addProcessor("PROCESS", () -> new LogProcessor(), "SOURCE")

.addSink("SINK", to, "PROCESS");

KafkaStreams streams = new KafkaStreams(build, settings);

streams.start();

}

}

将项目键入jar包中,将其上传到服务器,然后使用java -cp ****。jar cn.javayuli.kafkastream.KafkaStreamApp运行项目。

推荐服务

StreamingRecommender(非SpringBoot项目)

此处仅使用邮件,不进行推荐计算。

主要功能:

package cn.javayuli.streamrecommender;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

import java.time.Duration;

import java.util.Arrays;

import java.util.Properties;

/**

* @author hanguilin

*/

public class ConsumerApp {

public static void main(String[] args){

Properties properties = new Properties();

properties.put("bootstrap.servers", "192.168.1.43:9092");

properties.put("group.id", "group-1");

properties.put("enable.auto.commit", "true");

properties.put("auto.commit.interval.ms", "1000");

properties.put("auto.offset.reset", "earliest");

properties.put("session.timeout.ms", "30000");

properties.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

properties.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer kafkaConsumer = new KafkaConsumer(properties);

kafkaConsumer.subscribe(Arrays.asList("recommender"));

while (true) {

ConsumerRecords records = kafkaConsumer.poll(Duration.ofMillis(100));

for (ConsumerRecord record : records) {

System.out.printf("offset = %d, value = %s", record.offset(), record.value());

System.out.println();

}

}

}

}

将项目键入一个jar包中,将其上传到服务器,然后使用java -cp ****。jar cn.javayuli.streamrecommender.ConsumerApp运行该项目。

如果需要在非服务器上远程测试程序,则需要打开服务器的7001(BusinessServer)和9092(Kafka)端口。有关端口命令,请参阅文章“ CentOS7端口命令”。

数据模拟

发送评分请求:

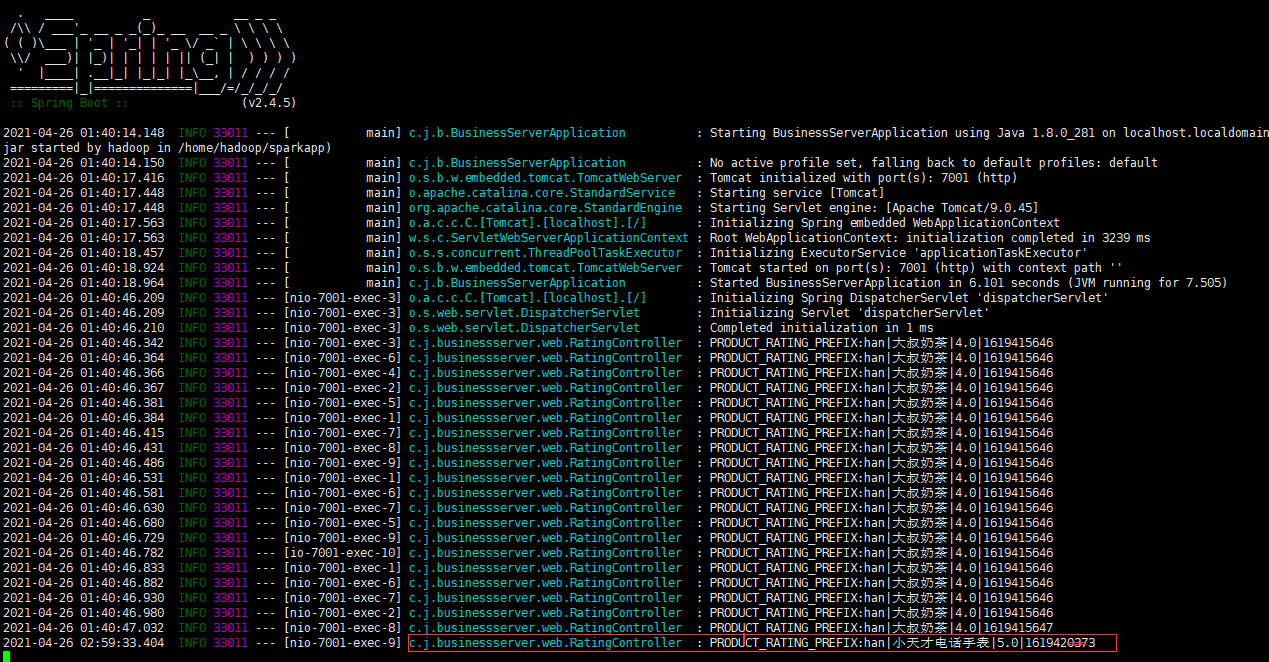

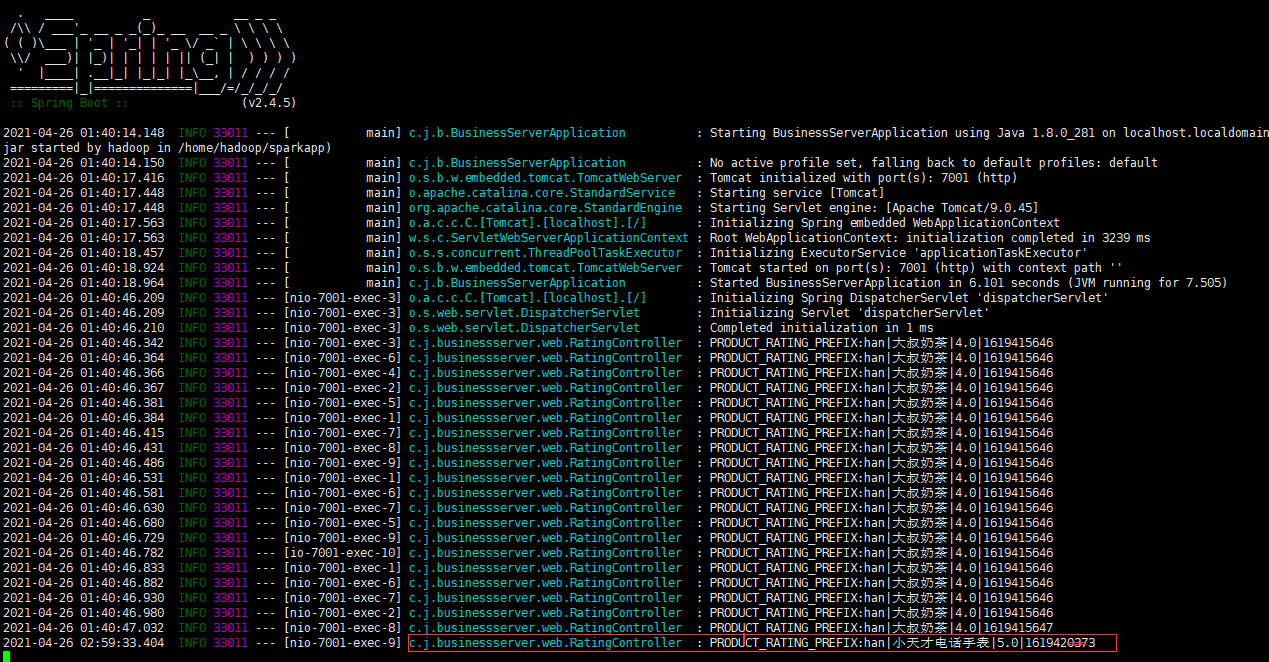

首先,产品服务将打印出日志:

查看/home/hadoop/flume/log/agent.log

如您所见,商品服务将日志附加到/home/hadoop/flume/log/agent.log文件。

这时,Flume检测到文件内容已更改,并将其他内容发送到Kafka日志主题。

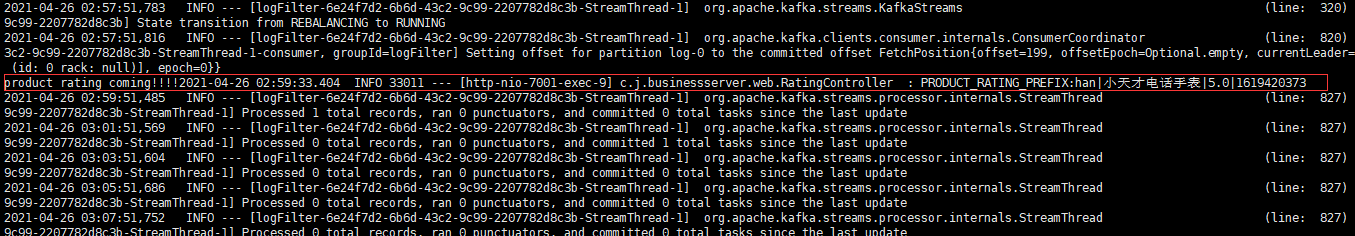

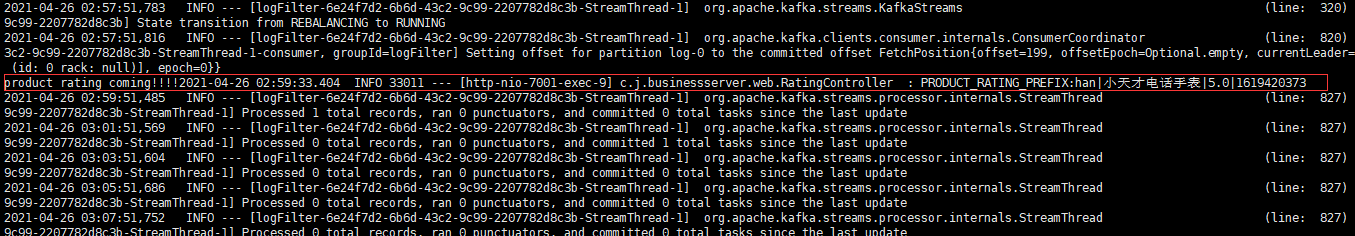

这时,清洁服务从日志主题中获取收录PRODUCT_RATING_PREFIX的日志信息,并将处理后的信息发送到推荐主题。

(下图显示从日志中取出的数据,而不是已处理的数据)

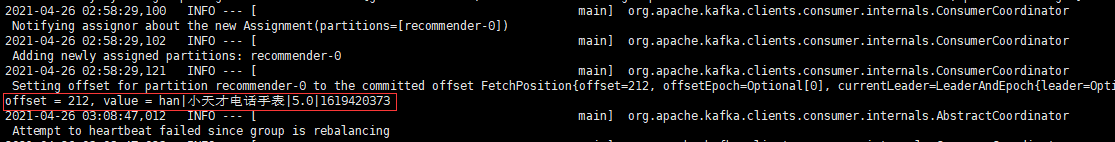

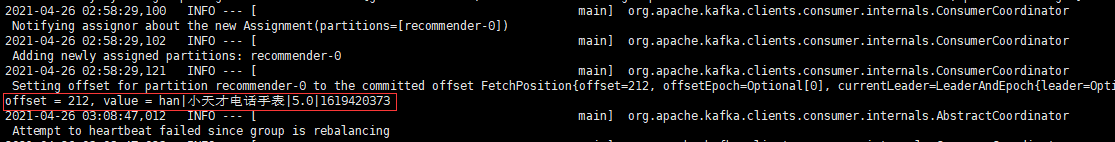

由于推荐服务订阅了推荐者主题,因此使用了该消息。

资源地址

只有关键代码发布在文章中,请检查git信息库“推荐”中的所有代码。 查看全部

【】监听文件中改动的内容及项目说明

项目说明

1、当用户在浏览器中单击产品以对产品进行评分时,将调用产品服务的界面。

2、评分界面通过记录器将用户,产品,评分和其他信息输出到文件中。

3、 Flume监视日志文件,并通过日志主题将日志信息发送到Kafka。

4、清洁服务接收从日志主题发送的消息,并通过关键字过滤掉有效信息,然后通过推荐主题将有效信息发送给Kafka。