采集自动组合

采集自动组合(优采云采集器3,独立的绿色软件,稳定易用,信息采集必备之选)

采集交流 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-02-06 11:21

优采云采集器3、网站自动内容更新工具,独立绿色软件,稳定好用,资讯必备采集。

【全自动无人值守】

无需人工值班,24小时自动实时监控目标,实时高效采集,全天候为您提供内容更新。满足长期运行的需求,让您摆脱繁重的工作量

【适用范围广】

最全能的采集软件,支持任意类型的网站采集,应用率高达99.9%,支持发布到所有类型的网站 程序等您可以在不发布接口的情况下采集本地文件。

【你想要的信息】

支持信息自由组合,通过强大的数据排序功能对信息进行深度处理,创造新的内容

【任意格式文件下载】

无论是静态还是动态,无论是图片、音乐、电影、软件,还是PDF文档、WORD文档,甚至是torrent文件,只要你想要

【伪原创】

高速同义词替换、随机多词替换、随机段落排序,助力内容SEO

【无限多级页面采集】

无论是垂直方向的多层页面,平行方向的复杂页面,还是AJAX调用的页面,都轻松搞定采集

【自由扩展】

开放接口模式,免费二次开发,自定义任意功能,实现所有需求

软件内置discuzX、phpwind、dedecms、wordpress、phpcms、empirecms、dongyi、joomla、pbdigg、php168、bbsxp、phpbb、dvbbs、typecho、emblog等常用系统的例子。 查看全部

采集自动组合(优采云采集器3,独立的绿色软件,稳定易用,信息采集必备之选)

优采云采集器3、网站自动内容更新工具,独立绿色软件,稳定好用,资讯必备采集。

【全自动无人值守】

无需人工值班,24小时自动实时监控目标,实时高效采集,全天候为您提供内容更新。满足长期运行的需求,让您摆脱繁重的工作量

【适用范围广】

最全能的采集软件,支持任意类型的网站采集,应用率高达99.9%,支持发布到所有类型的网站 程序等您可以在不发布接口的情况下采集本地文件。

【你想要的信息】

支持信息自由组合,通过强大的数据排序功能对信息进行深度处理,创造新的内容

【任意格式文件下载】

无论是静态还是动态,无论是图片、音乐、电影、软件,还是PDF文档、WORD文档,甚至是torrent文件,只要你想要

【伪原创】

高速同义词替换、随机多词替换、随机段落排序,助力内容SEO

【无限多级页面采集】

无论是垂直方向的多层页面,平行方向的复杂页面,还是AJAX调用的页面,都轻松搞定采集

【自由扩展】

开放接口模式,免费二次开发,自定义任意功能,实现所有需求

软件内置discuzX、phpwind、dedecms、wordpress、phpcms、empirecms、dongyi、joomla、pbdigg、php168、bbsxp、phpbb、dvbbs、typecho、emblog等常用系统的例子。

采集自动组合(影响搜索引擎排序的7大因素,唯独一个永不被改变的算法 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-02-06 05:13

)

影响搜索引擎排名的7个因素:

1、域名2、模板3、内容4、主机5、外链6、点击7、安全

SEO并没有那么神秘,它只是被很多人神化了。

成为网站就是养育一个孩子。

搜索引擎喜欢和好人打交道,你遵循它设定的游戏规则,它就会对你好。

搜索引擎系统是由人开发的,无论它多么智能,它都专注于人类的智慧。懂得如何与人相处,SEO就顺理成章了。

废话不多说,本次培训主要是针对很多seoer倾向玩的:采集站(交通站、体重站)

一个人的精力和时间是有限的,只有借助工具,才能事半功倍。不信可以手动写文章,慢慢发布文章。

一个网站,只有多了一个收录,才会引起连锁反应。如果一个站点收录有10000个页面,按照30%的索引概率,有3000个页面参与排名。如果排名都在榜首,则投放3000个广告。那是 10 站、20 站或更多,你可以拿一个计算器算一下。

如果你学会了计算的规则,你就会有一个目标去做,并达到你想要的结果。

内容相关性算法是众多算法中唯一不变的一种!一旦更改,搜索引擎就搞砸了!

想一想:我找香蕉,你给我看雪梨?(这个搜索结果完全违背了用户的搜索意图)

明白了吗?

软件工具(持续研发):

1、通用文章采集器/一机一码

2、多功能排版工具/一机一码

3、文件批处理器/一机一码

4、优采云采集器

5、文章组合工具/一机一码

6、超级写作文章生成工具

7、标题中的智能分词文章工具(自主研发)/一码一机

8、相关词自动采集插入文章工具(自主研发)/一机一码

9、BD-PC收录索引查询工具(自主研发)/一机一码

10、BD-相关结果值采集工具(自主研发)/一机一码

10、本地和服务器网站自动文件同步工具(防黑招)

11、SG-Ask采集器(自主研发)

12、网站文章Updater(dedecms,Empire,zblog,weardpress)/一机一码

部分工具界面显示:

一些 网站 效果:

查看全部

采集自动组合(影响搜索引擎排序的7大因素,唯独一个永不被改变的算法

)

影响搜索引擎排名的7个因素:

1、域名2、模板3、内容4、主机5、外链6、点击7、安全

SEO并没有那么神秘,它只是被很多人神化了。

成为网站就是养育一个孩子。

搜索引擎喜欢和好人打交道,你遵循它设定的游戏规则,它就会对你好。

搜索引擎系统是由人开发的,无论它多么智能,它都专注于人类的智慧。懂得如何与人相处,SEO就顺理成章了。

废话不多说,本次培训主要是针对很多seoer倾向玩的:采集站(交通站、体重站)

一个人的精力和时间是有限的,只有借助工具,才能事半功倍。不信可以手动写文章,慢慢发布文章。

一个网站,只有多了一个收录,才会引起连锁反应。如果一个站点收录有10000个页面,按照30%的索引概率,有3000个页面参与排名。如果排名都在榜首,则投放3000个广告。那是 10 站、20 站或更多,你可以拿一个计算器算一下。

如果你学会了计算的规则,你就会有一个目标去做,并达到你想要的结果。

内容相关性算法是众多算法中唯一不变的一种!一旦更改,搜索引擎就搞砸了!

想一想:我找香蕉,你给我看雪梨?(这个搜索结果完全违背了用户的搜索意图)

明白了吗?

软件工具(持续研发):

1、通用文章采集器/一机一码

2、多功能排版工具/一机一码

3、文件批处理器/一机一码

4、优采云采集器

5、文章组合工具/一机一码

6、超级写作文章生成工具

7、标题中的智能分词文章工具(自主研发)/一码一机

8、相关词自动采集插入文章工具(自主研发)/一机一码

9、BD-PC收录索引查询工具(自主研发)/一机一码

10、BD-相关结果值采集工具(自主研发)/一机一码

10、本地和服务器网站自动文件同步工具(防黑招)

11、SG-Ask采集器(自主研发)

12、网站文章Updater(dedecms,Empire,zblog,weardpress)/一机一码

部分工具界面显示:

一些 网站 效果:

采集自动组合(关于1.一种自动填充标记模块的说明及权利要求介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-01-30 12:26

1.一种自动填充标记模块,其特征在于它包括: 众所周知的htm1子模块,用于存储生成普通HTML页面的代码;自动填充语言子模块,用于存储自动填充和/或自动填充标记页面提交的代码;众所周知的 htm1 子模块收录自动填充语言子模块,用于生成具有自动填充和/或通过浏览器自动提交的 HTML 页面。

2、根据权利要求1所述的自动填充标记模块,其特征在于,所述填充语言子模块为符合HTML格式的模块。

3、根据权利要求2所述的自动填写标记模块,其特征在于,所述填写语言子模块包括:表单数据单元。

4、根据权利要求3所述的自动填充标记模块,其特征在于,所述数据包括:字段单元。

5、根据权利要求4所述的自动填充标记模块,其特征在于,字段单元。

6、根据权利要求4所述的自动填充标记模块,其特征在于,所述数据单元还包括:元素数据单元。

7、 一种浏览器组件,包括已知浏览器,其特征在于,加载有自动填充标记模块的浏览器生成自动填充HTML页面,其中自动填充标记模块包括众所周知的html子-模块用于存放生成普通HTML页面的代码;自动填充语言子模块用于存储标记页面自动填充和/或自动提交的代码;众所周知的html子块收录自动填充语言子模块生成具有自动填充和/或通过浏览器自动提交的HTML页面;还包括:浏览器,带有自动填充模块,自动填充模块用于监控浏览器,分析当前浏览的内容。网页,将用户资料中的信息自动填写到页面中相应的表单域中,并进行自动提交操作;浏览助手还有一个用户信息采集模块,用于获取用户在页面中输入的信息,并保存到用户档案中。

8、根据权利要求8所述的浏览器组件,其特征在于,所述浏览辅助、自动填表、自动填表、表单个数、字段包括,所有的表单号还带有浏览辅助和一个填充选项配置模块,用于提供自动提交设置选项。

9、如权利要求8所述的浏览器组件,其特征在于,所述自动填充语言子模块符合HTML格式的模块。

1.根据权利要求8所述的浏览器组件,其特征在于,所述自动填充语言子模块包括: 表单数据单元,用于存储各种表单数据。

1.根据权利要求11所述的浏览器组件,其特征在于,所述表单数据包括: 字段单元,用于存储各种字段数据。

1.根据权利要求12所述的浏览器组件,其中,所述字段包括用于存储各种字段数据的字^R单元。

1.根据权利要求11所述的浏览器组件,其特征在于,所述表单数据还包括: 元素数据单元,用于存储各种元素数据。 查看全部

采集自动组合(关于1.一种自动填充标记模块的说明及权利要求介绍)

1.一种自动填充标记模块,其特征在于它包括: 众所周知的htm1子模块,用于存储生成普通HTML页面的代码;自动填充语言子模块,用于存储自动填充和/或自动填充标记页面提交的代码;众所周知的 htm1 子模块收录自动填充语言子模块,用于生成具有自动填充和/或通过浏览器自动提交的 HTML 页面。

2、根据权利要求1所述的自动填充标记模块,其特征在于,所述填充语言子模块为符合HTML格式的模块。

3、根据权利要求2所述的自动填写标记模块,其特征在于,所述填写语言子模块包括:表单数据单元。

4、根据权利要求3所述的自动填充标记模块,其特征在于,所述数据包括:字段单元。

5、根据权利要求4所述的自动填充标记模块,其特征在于,字段单元。

6、根据权利要求4所述的自动填充标记模块,其特征在于,所述数据单元还包括:元素数据单元。

7、 一种浏览器组件,包括已知浏览器,其特征在于,加载有自动填充标记模块的浏览器生成自动填充HTML页面,其中自动填充标记模块包括众所周知的html子-模块用于存放生成普通HTML页面的代码;自动填充语言子模块用于存储标记页面自动填充和/或自动提交的代码;众所周知的html子块收录自动填充语言子模块生成具有自动填充和/或通过浏览器自动提交的HTML页面;还包括:浏览器,带有自动填充模块,自动填充模块用于监控浏览器,分析当前浏览的内容。网页,将用户资料中的信息自动填写到页面中相应的表单域中,并进行自动提交操作;浏览助手还有一个用户信息采集模块,用于获取用户在页面中输入的信息,并保存到用户档案中。

8、根据权利要求8所述的浏览器组件,其特征在于,所述浏览辅助、自动填表、自动填表、表单个数、字段包括,所有的表单号还带有浏览辅助和一个填充选项配置模块,用于提供自动提交设置选项。

9、如权利要求8所述的浏览器组件,其特征在于,所述自动填充语言子模块符合HTML格式的模块。

1.根据权利要求8所述的浏览器组件,其特征在于,所述自动填充语言子模块包括: 表单数据单元,用于存储各种表单数据。

1.根据权利要求11所述的浏览器组件,其特征在于,所述表单数据包括: 字段单元,用于存储各种字段数据。

1.根据权利要求12所述的浏览器组件,其中,所述字段包括用于存储各种字段数据的字^R单元。

1.根据权利要求11所述的浏览器组件,其特征在于,所述表单数据还包括: 元素数据单元,用于存储各种元素数据。

采集自动组合( vucf自动发帖软件别让发帖占用你的时间(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2022-01-29 12:12

vucf自动发帖软件别让发帖占用你的时间(图))

列表网络自动发帖助手点我(2020新版)

列表网络自动发帖助手点我(2020新版)vucf

自动发帖软件,别让发帖占用你的时间

AiPublishing--企业信息助手:分类问讯台和B2B站的通用出版信息软件。不仅取代人工,实现全自动发布软件,还可以自动切换标题、内容、图片等。

软件支持自动随机生成标题,自动发帖软件自动插入国家城市名和任意结尾词,标题对应内容,自动上传图片,可以将无数句子组合成不同的原创内容,只要你发布好,秒收!自动发帖软件软件可以从已设置的不同内容中随机选择一个内容

列表网络自动发帖助手点我(2020新版)

产品推广、信息发布、自动海报、B2B发布、自动发布、自动信息发布。@Software 的特色优势。1.软件一个软件可以发很多b2b站,我们是一个网站一个脚本,所以买一套软件,不同的脚本可以处理所有的网站2.软件是的,包升级。我们有一个专门的团队。如果软件无法发送,则表示他们的平台已经升级。此时,我们的技术会立即升级我们的脚本,我们会及时将新的脚本发送给您。3.软件简单易用。首先,您必须了解计算机的基础知识。只要你会打字、复制、粘贴都可以,我们的客服会教你远程使用。确保您获得我们的软件,并且每个人都会使用它。4.软件可以多开,十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。并且不占用计算机资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。并且不占用计算机资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。但也涵盖了一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。但也涵盖了一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。

节省时间和麻烦。自动设置产品图片功能图片有3种方式:同步采集网站图片。如果你在网站的后台上传了一张图片,点击“采集相册”自动采集图片到本地。你的网站后台获取URL地址,并为你要发送的产品拍照。在本地计算机上手动批量导入图片。功能强大的内容编辑软件,内置文本编辑器,自动识别内容提交格式是纯文本还是html文本。html文本可以在软件内部随时进行可视化编辑,就像网站的后台操作一样。能' 没想到很多标题都带有自动合成标题功能?软件内置批量合成标题功能,自动批量合成数千个独特标题。根据您的需要,配置要生成的标题模板。标题可以任意组合,常用格式为【字符1】【字符2】【字符3】,通过各种自定义组合。可以生产万花筒号。

艾发布B2B助手功能介绍:

一、定时发送函数

软件发布信息间隔时间不规律,随意调整间隔时间,使每两条信息的间隔时间不规律,定时关机功能(一般适合晚上发布信息的朋友,发布后自动关机)。

二、保存配置函数

如果您有多个产品需要单独发布,可以分别保存产品功能的配置。您只需要配置一次。保存配置后,稍后导入配置以加载之前的设置,省时省事。

三、自动设置商品图片功能

图像有 3 个选项:

1、同步采集网站图片。如果你在网站的后台上传了一张图片,点击“采集相册”自动采集图片到本地。

2、你的网站后台获取URL地址,对你要发送的产品拍照。

3、从本地计算机手动批量导入图片。

四、强大的内容编辑器

软件内置文本编辑器,自动识别网站的内容提交格式是纯文本还是html文本。html文本可以在软件内部随时进行可视化编辑,就像网站的后台操作一样。

五、自动合成标题功能

想不出很多标题?软件内置批量合成标题功能,自动批量合成数千个独特标题。根据您的需要,配置要生成的标题模板。

标题可以任意组合。常见的格式是{character 1}{character 2}{character 3}。通过各种自定义组合,可以生成千变万化的标题。

六、自动插入伪原创 功能

为了保证每次发布的内容不重复,爱发布b2b助手有两种格式。

世界在不断发展,美国的局势也在日益恶化。持续的价差有助于提振对黄金(GOLD)的需求。Worldometers实时经济统计数据显示,全球肺炎累计确诊病例已超过6130万例,累计病例已超过143.7万例。美国肺炎确诊病例累计超过1324万例,累计病例超过26.9万例。据《大西洋月刊》发起的追踪美国项目公布的经济数据显示,美国肺炎住院患者已达9万人,创下疫情暴发以来的最高纪录。信息。美国累计确诊病例超过1324万,人数超过26.9万。美国单日确诊病例超过1200例。当地时间11月26日,美国表示最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。美国方面表示,最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。美国方面表示,最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。

全球肺炎确诊病例累计突破6354万例,达1例。累计病例突破147.3万例,达150万例。美国肺炎确诊病例累计突破1390万,达10万,单日新增逾14万;累计病例数超过27.40,000,达到1,000。据《大西洋月刊》发起的追踪美国项目公布的经济数据显示,美国肺炎住院患者达到93265人,创疫情以来新高。当地时间11月30日,世界卫生组织(WHO)肺炎例行。世卫组织总干事谭德塞表示,疾病溯源专家组成员名单已经公布,其中包括来自英国、美国等国的专家。世卫组织的立场一直很明确。研究应该以科学为基础,世卫组织将尽一切可能了解疾病的根源。并呼吁大家在这个问题上进行合作。11月30日,据国内经济数据公布。

自 1 月 14 日以来的收盘价受到对美国库存增加和需求增长下降的担忧的影响。据该机构报道,本周,一群德国经济学家和企业家在德国对欧元提出了投诉。这将导致中德矛盾的加深。该货币受到德国的抨击。德国不断抱怨低利率正在损害德国养老金,这可能会引发亲右翼情绪。据德国WeltamSonntag媒体报道,此次上诉的主要目的是决定扩大购债规模计划和扩大QE范围是否越权。提出投诉的经济学和企业家表示,该货币对德国资产的财务健康以及德国纳税人构成了无法估量的威胁,并且 2% 的货币目标只是一个幌子。投诉是由 Markus Kerber 发起的。Markus Kerber 是一名律师和公共财政部门。他说,目前的货币是不必要的。

nu8lg1za 查看全部

采集自动组合(

vucf自动发帖软件别让发帖占用你的时间(图))

列表网络自动发帖助手点我(2020新版)

列表网络自动发帖助手点我(2020新版)vucf

自动发帖软件,别让发帖占用你的时间

AiPublishing--企业信息助手:分类问讯台和B2B站的通用出版信息软件。不仅取代人工,实现全自动发布软件,还可以自动切换标题、内容、图片等。

软件支持自动随机生成标题,自动发帖软件自动插入国家城市名和任意结尾词,标题对应内容,自动上传图片,可以将无数句子组合成不同的原创内容,只要你发布好,秒收!自动发帖软件软件可以从已设置的不同内容中随机选择一个内容

列表网络自动发帖助手点我(2020新版)

产品推广、信息发布、自动海报、B2B发布、自动发布、自动信息发布。@Software 的特色优势。1.软件一个软件可以发很多b2b站,我们是一个网站一个脚本,所以买一套软件,不同的脚本可以处理所有的网站2.软件是的,包升级。我们有一个专门的团队。如果软件无法发送,则表示他们的平台已经升级。此时,我们的技术会立即升级我们的脚本,我们会及时将新的脚本发送给您。3.软件简单易用。首先,您必须了解计算机的基础知识。只要你会打字、复制、粘贴都可以,我们的客服会教你远程使用。确保您获得我们的软件,并且每个人都会使用它。4.软件可以多开,十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。并且不占用计算机资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。并且不占用计算机资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。但也涵盖了一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。但也涵盖了一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。

节省时间和麻烦。自动设置产品图片功能图片有3种方式:同步采集网站图片。如果你在网站的后台上传了一张图片,点击“采集相册”自动采集图片到本地。你的网站后台获取URL地址,并为你要发送的产品拍照。在本地计算机上手动批量导入图片。功能强大的内容编辑软件,内置文本编辑器,自动识别内容提交格式是纯文本还是html文本。html文本可以在软件内部随时进行可视化编辑,就像网站的后台操作一样。能' 没想到很多标题都带有自动合成标题功能?软件内置批量合成标题功能,自动批量合成数千个独特标题。根据您的需要,配置要生成的标题模板。标题可以任意组合,常用格式为【字符1】【字符2】【字符3】,通过各种自定义组合。可以生产万花筒号。

艾发布B2B助手功能介绍:

一、定时发送函数

软件发布信息间隔时间不规律,随意调整间隔时间,使每两条信息的间隔时间不规律,定时关机功能(一般适合晚上发布信息的朋友,发布后自动关机)。

二、保存配置函数

如果您有多个产品需要单独发布,可以分别保存产品功能的配置。您只需要配置一次。保存配置后,稍后导入配置以加载之前的设置,省时省事。

三、自动设置商品图片功能

图像有 3 个选项:

1、同步采集网站图片。如果你在网站的后台上传了一张图片,点击“采集相册”自动采集图片到本地。

2、你的网站后台获取URL地址,对你要发送的产品拍照。

3、从本地计算机手动批量导入图片。

四、强大的内容编辑器

软件内置文本编辑器,自动识别网站的内容提交格式是纯文本还是html文本。html文本可以在软件内部随时进行可视化编辑,就像网站的后台操作一样。

五、自动合成标题功能

想不出很多标题?软件内置批量合成标题功能,自动批量合成数千个独特标题。根据您的需要,配置要生成的标题模板。

标题可以任意组合。常见的格式是{character 1}{character 2}{character 3}。通过各种自定义组合,可以生成千变万化的标题。

六、自动插入伪原创 功能

为了保证每次发布的内容不重复,爱发布b2b助手有两种格式。

世界在不断发展,美国的局势也在日益恶化。持续的价差有助于提振对黄金(GOLD)的需求。Worldometers实时经济统计数据显示,全球肺炎累计确诊病例已超过6130万例,累计病例已超过143.7万例。美国肺炎确诊病例累计超过1324万例,累计病例超过26.9万例。据《大西洋月刊》发起的追踪美国项目公布的经济数据显示,美国肺炎住院患者已达9万人,创下疫情暴发以来的最高纪录。信息。美国累计确诊病例超过1324万,人数超过26.9万。美国单日确诊病例超过1200例。当地时间11月26日,美国表示最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。美国方面表示,最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。美国方面表示,最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。

全球肺炎确诊病例累计突破6354万例,达1例。累计病例突破147.3万例,达150万例。美国肺炎确诊病例累计突破1390万,达10万,单日新增逾14万;累计病例数超过27.40,000,达到1,000。据《大西洋月刊》发起的追踪美国项目公布的经济数据显示,美国肺炎住院患者达到93265人,创疫情以来新高。当地时间11月30日,世界卫生组织(WHO)肺炎例行。世卫组织总干事谭德塞表示,疾病溯源专家组成员名单已经公布,其中包括来自英国、美国等国的专家。世卫组织的立场一直很明确。研究应该以科学为基础,世卫组织将尽一切可能了解疾病的根源。并呼吁大家在这个问题上进行合作。11月30日,据国内经济数据公布。

自 1 月 14 日以来的收盘价受到对美国库存增加和需求增长下降的担忧的影响。据该机构报道,本周,一群德国经济学家和企业家在德国对欧元提出了投诉。这将导致中德矛盾的加深。该货币受到德国的抨击。德国不断抱怨低利率正在损害德国养老金,这可能会引发亲右翼情绪。据德国WeltamSonntag媒体报道,此次上诉的主要目的是决定扩大购债规模计划和扩大QE范围是否越权。提出投诉的经济学和企业家表示,该货币对德国资产的财务健康以及德国纳税人构成了无法估量的威胁,并且 2% 的货币目标只是一个幌子。投诉是由 Markus Kerber 发起的。Markus Kerber 是一名律师和公共财政部门。他说,目前的货币是不必要的。

nu8lg1za

采集自动组合(数据采集平台_数据合并伴侣V208c.xls(图解))

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2022-01-26 19:17

一、采集Platform Data Merging Companion Introduction1)“采集Platform_Data Merging Companion V208c.xls”是Data采集平台的辅助工具,其主要功能 用于数据表文件回收、数据合并、数据表版本转换。请注意,这些函数必须在允许宏操作的环境中使用。2)合并伙伴组成:1个伴生文件,若干个文件目录(如下图所示) 图11:合并伙伴组成图二、宏在平台中的作用1)查看状态数据2)数据输入3)数据汇总操作4)允许智能表操作(如:表导出/导入、表解锁/锁定、格式刷新、数据汇总等)三、 启用宏操作 必须启用宏才能在 Excel 中执行主平台文件。启用方法如下: 打开Excel文件,选择菜单打开安全对话框,将安全级别设置为“低”。具体操作图请参考《1.@ >4 启动Excel(VBA)宏运行环境》。Excel四、数据表填写1)打开数据表文件,根据表项输入数据注意:每个数据表的上半部分是版本标识,返回主目录的链接,栏目描述和评论,请在输入数据前仔细阅读。图25:待填单表2) 完成数据输入后,保存文件并按规定重命名文件(部分表格) 例如:网络教研室填写《A4-2校外实习实训基地表(教研室)》。采集)”文件更名为:“A4-2校外实习实训基地表(网络教研室采集)”五、数据表恢复与合并1)@ >

4)导出合并后的数据表,在页面选择“导出文件”按钮,直到出现提示,按“确定”按钮,导出成功。图 31:执行“导出文件”按钮后,组合表自动导出到“回收数据表”目录 图 32:“回收数据表”中的组合表“A7-1 Professional Settings Table.xls”文件目录六、状态数据采集解惑目前需要上报状态数据采集平台文件,数据指标固定,所以采集@中的数据列>不能添加平台和减少,否则会影响数据的统计和聚合(第 10 节)。个性化数据采集 和处理可以在未来的网络版本中实现。如果未上报的EXCEL文件可以在解锁数据栏后添加或删除。 查看全部

采集自动组合(数据采集平台_数据合并伴侣V208c.xls(图解))

一、采集Platform Data Merging Companion Introduction1)“采集Platform_Data Merging Companion V208c.xls”是Data采集平台的辅助工具,其主要功能 用于数据表文件回收、数据合并、数据表版本转换。请注意,这些函数必须在允许宏操作的环境中使用。2)合并伙伴组成:1个伴生文件,若干个文件目录(如下图所示) 图11:合并伙伴组成图二、宏在平台中的作用1)查看状态数据2)数据输入3)数据汇总操作4)允许智能表操作(如:表导出/导入、表解锁/锁定、格式刷新、数据汇总等)三、 启用宏操作 必须启用宏才能在 Excel 中执行主平台文件。启用方法如下: 打开Excel文件,选择菜单打开安全对话框,将安全级别设置为“低”。具体操作图请参考《1.@ >4 启动Excel(VBA)宏运行环境》。Excel四、数据表填写1)打开数据表文件,根据表项输入数据注意:每个数据表的上半部分是版本标识,返回主目录的链接,栏目描述和评论,请在输入数据前仔细阅读。图25:待填单表2) 完成数据输入后,保存文件并按规定重命名文件(部分表格) 例如:网络教研室填写《A4-2校外实习实训基地表(教研室)》。采集)”文件更名为:“A4-2校外实习实训基地表(网络教研室采集)”五、数据表恢复与合并1)@ >

4)导出合并后的数据表,在页面选择“导出文件”按钮,直到出现提示,按“确定”按钮,导出成功。图 31:执行“导出文件”按钮后,组合表自动导出到“回收数据表”目录 图 32:“回收数据表”中的组合表“A7-1 Professional Settings Table.xls”文件目录六、状态数据采集解惑目前需要上报状态数据采集平台文件,数据指标固定,所以采集@中的数据列>不能添加平台和减少,否则会影响数据的统计和聚合(第 10 节)。个性化数据采集 和处理可以在未来的网络版本中实现。如果未上报的EXCEL文件可以在解锁数据栏后添加或删除。

采集自动组合(SKYCC组合营销软件里面的多样化采集功能有哪些?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-01-26 15:21

SKYCC组合营销软件新亮点:多元化采集 SKYCC组合营销软件自2012年推出以来,一直关注SKYCC组合营销软件的相关报道,一一披露了SKYCC的主要特点。随着组合营销软件的诞生,大家除了了解它的主要特点外,肯定也想关注它的小亮点。下面分析SKYCC组合营销软件采集的多元化。我们都知道,一个好的文章对于一个网站关键词的优化起着重要的作用,无论是企业推广人员还是SEO优化人员。但是没时间写文章怎么办,可能是因为文章太多了 需要吗?SKYCC 多样的采集 可以解决这些问题。SKYCC混合营销软件的文章添加分为3种模式(全自动采集、半自动采集、手动添加)。下面介绍全自动采集 和半自动采集。SKYCC组合营销软件采集有两个功能:第一个采集功能(自动采集)采集文章功能很简单,只需要输入自定义 关键词。点击“开始搜索”,可以自动快速采集搜索到大量的文章,包括你的关键词,让你再也不用担心写文章了。第二种采集功能(半自动采集 ) 需要一点程序基础。软件会根据你填写的采集规则在特定页面批量采集文章,采集成功文章会自动添加到“文章 管理”列表。采集或者添加完文章之后,还可以使用SKYCC组合营销软件内置的伪原创功能,增加文章的原创性质. 收录效果大大增强。直接提高营销效果。您还可以利用SKYCC组合营销软件内置的伪原创功能,增加文章的原创性质。收录效果大大增强。直接提高营销效果。您还可以利用SKYCC组合营销软件内置的伪原创功能,增加文章的原创性质。收录效果大大增强。直接提高营销效果。 查看全部

采集自动组合(SKYCC组合营销软件里面的多样化采集功能有哪些?)

SKYCC组合营销软件新亮点:多元化采集 SKYCC组合营销软件自2012年推出以来,一直关注SKYCC组合营销软件的相关报道,一一披露了SKYCC的主要特点。随着组合营销软件的诞生,大家除了了解它的主要特点外,肯定也想关注它的小亮点。下面分析SKYCC组合营销软件采集的多元化。我们都知道,一个好的文章对于一个网站关键词的优化起着重要的作用,无论是企业推广人员还是SEO优化人员。但是没时间写文章怎么办,可能是因为文章太多了 需要吗?SKYCC 多样的采集 可以解决这些问题。SKYCC混合营销软件的文章添加分为3种模式(全自动采集、半自动采集、手动添加)。下面介绍全自动采集 和半自动采集。SKYCC组合营销软件采集有两个功能:第一个采集功能(自动采集)采集文章功能很简单,只需要输入自定义 关键词。点击“开始搜索”,可以自动快速采集搜索到大量的文章,包括你的关键词,让你再也不用担心写文章了。第二种采集功能(半自动采集 ) 需要一点程序基础。软件会根据你填写的采集规则在特定页面批量采集文章,采集成功文章会自动添加到“文章 管理”列表。采集或者添加完文章之后,还可以使用SKYCC组合营销软件内置的伪原创功能,增加文章的原创性质. 收录效果大大增强。直接提高营销效果。您还可以利用SKYCC组合营销软件内置的伪原创功能,增加文章的原创性质。收录效果大大增强。直接提高营销效果。您还可以利用SKYCC组合营销软件内置的伪原创功能,增加文章的原创性质。收录效果大大增强。直接提高营销效果。

采集自动组合(解析SKYCC组合营销软件里面的多样化采集功能!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2022-01-26 15:20

自2012年2月SKYCC组合营销软件上线以来,SKYCC组合营销软件的相关报道也一直被关注,SKYCC的主要特点一一披露。随着组合营销软件的诞生,大家除了了解它的主要特点外,肯定也想关注它的小亮点。下面我们来分析一下SKYCC组合营销软件采集的多元化。

我们都知道,一个好的文章在网站关键词的优化中扮演着重要的角色,无论是企业推广人员还是SEO优化人员。但是当我们没有时间写 文章 时,我们该怎么办,也许是因为需要的 文章 太多了?SKYCC 多样的采集 可以解决这些问题。SKYCC组合营销软件的文章添加分为3种模式(全自动采集、半自动采集、手动添加)。下面来看看全自动采集和半自动采集。

SKYCC组合营销软件采集的功能分为两种:

第一个采集函数(自动采集)采集文章函数很简单,输入自定义关键词即可。点击“开始搜索”,可以自动快速采集搜索到大量的文章,包括你的关键词,让你再也不用担心写文章了。

第二种采集函数(半自动采集)需要一点编程基础。软件会根据你填写的采集规则在特定页面批量采集文章,采集成功文章会自动添加到“文章 管理”列表。

采集或者添加文章后,也可以使用SKYCC组合营销软件内置的伪原创功能,增加文章的原创属性。收录效果大大增强。直接提高营销效果。 查看全部

采集自动组合(解析SKYCC组合营销软件里面的多样化采集功能!)

自2012年2月SKYCC组合营销软件上线以来,SKYCC组合营销软件的相关报道也一直被关注,SKYCC的主要特点一一披露。随着组合营销软件的诞生,大家除了了解它的主要特点外,肯定也想关注它的小亮点。下面我们来分析一下SKYCC组合营销软件采集的多元化。

我们都知道,一个好的文章在网站关键词的优化中扮演着重要的角色,无论是企业推广人员还是SEO优化人员。但是当我们没有时间写 文章 时,我们该怎么办,也许是因为需要的 文章 太多了?SKYCC 多样的采集 可以解决这些问题。SKYCC组合营销软件的文章添加分为3种模式(全自动采集、半自动采集、手动添加)。下面来看看全自动采集和半自动采集。

SKYCC组合营销软件采集的功能分为两种:

第一个采集函数(自动采集)采集文章函数很简单,输入自定义关键词即可。点击“开始搜索”,可以自动快速采集搜索到大量的文章,包括你的关键词,让你再也不用担心写文章了。

第二种采集函数(半自动采集)需要一点编程基础。软件会根据你填写的采集规则在特定页面批量采集文章,采集成功文章会自动添加到“文章 管理”列表。

采集或者添加文章后,也可以使用SKYCC组合营销软件内置的伪原创功能,增加文章的原创属性。收录效果大大增强。直接提高营销效果。

采集自动组合(约束和触发器在特殊情况下的各有优势。(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-01-26 15:17

约束和触发器在特殊情况下各有优势。触发器的主要好处是它们可以收录使用 Transact-SQL 代码的复杂处理逻辑。因此,触发器可以支持约束的所有功能;但这并不总是提供给定功能的最佳方法。实体完整性应始终通过作为 PRIMARY KEY 和 UNIQUE 约束的一部分或独立于约束创建的索引在最低级别强制执行。域完整性应该通过 CHECK 约束来强制执行,而参照完整性 (RI) 应该通过 FOREIGN KEY 约束来强制执行,假设功能可以满足应用程序的功能需求。当约束支持的功能不能满足应用程序的功能需求时,触发器非常有用。

例如:除非 REFERENCES 子句定义了级联引用操作,否则 FOREIGN KEY 约束只能验证具有与另一列中的值完全匹配的值的列值。

CHECK 约束只能针对逻辑表达式或同一张表中的另一列验证列值。如果应用程序需要针对另一个表中的列验证列值,则必须使用触发器。约束只能通过标准系统错误消息传递错误消息。如果应用程序需要(或受益于)自定义信息和更复杂的错误处理,则必须使用触发器。

触发器可以通过数据库中的相关表级联更改;但是,通过级联引用完整性约束可以更有效地执行这些更改。触发器可以抑制或回滚违反参照完整性的更改,从而取消尝试的数据修改。当外键更改并且新值与主键不匹配时,此类触发器可能会发挥作用。例如,您可以在 titleauthor.title_id 上创建插入触发器,如果新值与titles.title_id 中的值不匹配,则回滚插入。但是,通常为此目的使用外键。

如果触发器表上存在约束,则会在 INSTEAD OF 触发器执行之后但在 AFTER 触发器执行之前检查它们。如果约束被破坏,INSTEAD OF 触发器操作将回滚并且不执行 AFTER 触发器。

最后可以在视图上创建触发器吗?在 SQL Server™ 联机丛书中,并没有说不能在视图上创建触发器,在语法解释中指出它可以是 CREATE TRIGGER 为 ON 后的视图。然而,情况似乎并非如此,许多专家还表示,不能在视图上创建触发器。我也专门做了个测试,是真的,不管是普通视图还是索引视图,都不可能在上面创建触发器,是真的吗?

但这并没有什么问题:在临时表或系统表上创建触发器时,触发器将被拒绝。

深入理解FOR CREATE TRIGGER语句后可以跟INSERT、UPDATE、DELETE中的一种或多种,即在其他情况下不会触发触发器,包括SELECT、TRUNCATE、WRITETEXT、UPDATETEXT。

相关内容 一个有趣的应用我们看到很多注册系统注册后是不能更改用户名的,但这多是由应用决定的,如果直接打开数据库表更改,也可以更改其用户名,在触发器中使用回滚,可以巧妙的实现不能更改用户名... 详情 当触发器的内部语句失败... 这种情况下,之前的数据更改操作将失效。例如,当向表中插入数据时触发触发器,并且触发器内部发生运行时错误,将返回错误值并拒绝之前的数据插入。不能在触发器中使用的语句 大多数 T-SQL 语句都可以在触发器中使用,但以下某些语句不能在触发器中使用。

CREATE 语句,如:CREATE DATABASE、CREATE TABLE、CREATE INDEX 等。

ALTER 语句,如:ALTER DATABASE、ALTER TABLE、ALTER INDEX 等。

DROP 语句,如:DROP DATABASE、DROP TABLE、DROP INDEX 等。

DISK语句,如:DISK INIT、DISK RESIZE。

LOAD 语句,如:LOAD DATABASE、LOAD LOG。

RESTORE 语句,如:RESTORE DATABASE、RESTORE LOG。

重新配置

TRUNCATE TABLE 语句不能在 sybase 触发器中使用! 查看全部

采集自动组合(约束和触发器在特殊情况下的各有优势。(一))

约束和触发器在特殊情况下各有优势。触发器的主要好处是它们可以收录使用 Transact-SQL 代码的复杂处理逻辑。因此,触发器可以支持约束的所有功能;但这并不总是提供给定功能的最佳方法。实体完整性应始终通过作为 PRIMARY KEY 和 UNIQUE 约束的一部分或独立于约束创建的索引在最低级别强制执行。域完整性应该通过 CHECK 约束来强制执行,而参照完整性 (RI) 应该通过 FOREIGN KEY 约束来强制执行,假设功能可以满足应用程序的功能需求。当约束支持的功能不能满足应用程序的功能需求时,触发器非常有用。

例如:除非 REFERENCES 子句定义了级联引用操作,否则 FOREIGN KEY 约束只能验证具有与另一列中的值完全匹配的值的列值。

CHECK 约束只能针对逻辑表达式或同一张表中的另一列验证列值。如果应用程序需要针对另一个表中的列验证列值,则必须使用触发器。约束只能通过标准系统错误消息传递错误消息。如果应用程序需要(或受益于)自定义信息和更复杂的错误处理,则必须使用触发器。

触发器可以通过数据库中的相关表级联更改;但是,通过级联引用完整性约束可以更有效地执行这些更改。触发器可以抑制或回滚违反参照完整性的更改,从而取消尝试的数据修改。当外键更改并且新值与主键不匹配时,此类触发器可能会发挥作用。例如,您可以在 titleauthor.title_id 上创建插入触发器,如果新值与titles.title_id 中的值不匹配,则回滚插入。但是,通常为此目的使用外键。

如果触发器表上存在约束,则会在 INSTEAD OF 触发器执行之后但在 AFTER 触发器执行之前检查它们。如果约束被破坏,INSTEAD OF 触发器操作将回滚并且不执行 AFTER 触发器。

最后可以在视图上创建触发器吗?在 SQL Server™ 联机丛书中,并没有说不能在视图上创建触发器,在语法解释中指出它可以是 CREATE TRIGGER 为 ON 后的视图。然而,情况似乎并非如此,许多专家还表示,不能在视图上创建触发器。我也专门做了个测试,是真的,不管是普通视图还是索引视图,都不可能在上面创建触发器,是真的吗?

但这并没有什么问题:在临时表或系统表上创建触发器时,触发器将被拒绝。

深入理解FOR CREATE TRIGGER语句后可以跟INSERT、UPDATE、DELETE中的一种或多种,即在其他情况下不会触发触发器,包括SELECT、TRUNCATE、WRITETEXT、UPDATETEXT。

相关内容 一个有趣的应用我们看到很多注册系统注册后是不能更改用户名的,但这多是由应用决定的,如果直接打开数据库表更改,也可以更改其用户名,在触发器中使用回滚,可以巧妙的实现不能更改用户名... 详情 当触发器的内部语句失败... 这种情况下,之前的数据更改操作将失效。例如,当向表中插入数据时触发触发器,并且触发器内部发生运行时错误,将返回错误值并拒绝之前的数据插入。不能在触发器中使用的语句 大多数 T-SQL 语句都可以在触发器中使用,但以下某些语句不能在触发器中使用。

CREATE 语句,如:CREATE DATABASE、CREATE TABLE、CREATE INDEX 等。

ALTER 语句,如:ALTER DATABASE、ALTER TABLE、ALTER INDEX 等。

DROP 语句,如:DROP DATABASE、DROP TABLE、DROP INDEX 等。

DISK语句,如:DISK INIT、DISK RESIZE。

LOAD 语句,如:LOAD DATABASE、LOAD LOG。

RESTORE 语句,如:RESTORE DATABASE、RESTORE LOG。

重新配置

TRUNCATE TABLE 语句不能在 sybase 触发器中使用!

采集自动组合(如下在流批一体的探索构建一体准实时数仓应用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2022-01-26 07:16

基于Hive的离线数据仓库往往是企业大数据生产系统中不可或缺的一部分。Hive数据仓库成熟度和稳定性高,但是因为离线,延迟非常大。在一些时延要求较高的场景下,需要构建基于 Flink 的实时数仓,将链路时延降低到秒级。但是一套离线数仓和一套实时数仓的架构会带来一倍以上的资源消耗,甚至导致重复开发。

我是否必须放弃现有的 Hive 数据仓库来构建流式链接?不,在 Flink 的帮助下,现有的 Hive 离线数仓可以做到准实时。本文由 Apache Flink Committer 和阿里巴巴技术专家李劲松在 InfoQ 技术公开课上的分享整理而成。文章 将分析当前离线实时数仓的难点,并详细讲解 Flink 如何解决 Hive 流审批和准实时数仓的问题。,实现更高效、更合理的资源配置。文章大纲如下:

实时离线数仓难点 Flink 流批融合与准实时数仓的探索与建设 实时离线数仓应用实践难点

线下仓库

上图是一个典型的离线数据仓库。假设公司现在有需求。目前,公司拥有大量数据。它需要每天生成一个报表,并输出到业务数据库中。第一种是刚刚入库的业务数据,大致分为两种,一种是MySQL binlog,一种是业务系统中的业务管理。这个日志管理信息可以通过Flume等工具发送到采集,然后离线存储到仓库。那么随着业务越来越多,业务中的每个表都可以抽象出来。抽象的好处是更好的管理和更有效的数据重用和计算重用。因此,数据仓库分为多层(细节层、中间层、服务层等),

不仅仅是HiveSQL,Hive只是静态批量计算,业务需要每天上报,也就是说每天都在进行计算。在这种情况下,它将取决于调度工具和血统管理:

当任务非常大的时候,我们往往需要很长时间才能得到结果,也就是我们常说的T+1、H+1,这就是离线数仓的问题。

第三方工具

如前所述,离线数仓不仅仅是简单的 Hive 计算,它还依赖于其他第三方工具,例如:

无论是离线数仓还是第三方工具,主要的问题其实是“慢”。如何解决慢的问题,是时候出现实时数据仓库了。

实时数据仓库

实时数仓其实是从 Hive+HDFS 的组合变成了 Kafka,而 ETL 的功能是通过 Flink 的流处理来解决的。这个时候,调度和血缘管理就没有问题了。通过实时不断的增量更新,最终输出到业务DB。

虽然延迟降低了,但是这时候我们会面临一些其他的问题:

Lambda 架构

所以这个时候很多人会选择一套实时和一套离线的方式,互不干扰,根据任务是否需要遵循实时的要求来分离需求。

这种架构看似解决了所有问题,但实际上带来了很多问题。首先,Lambda 架构将离线和实时分开。他们解决的业务问题是相同的,但是两种解决方案从同一个数据源产生不同的计算结果。不同层级的表结构可能不一致,当出现数据不一致时,需要对比检查。

随着这个 Lambda 架构越走越远,开发团队、表结构表依赖、计算模型等可能会分离。越走越会发现成本越来越高,统一的成本也越来越大。.

那么问题来了,实时数仓会消耗这么大的资源,历史数据无法保留。Lambda 架构中存在很多问题。有哪些解决方案可以解决?

数据湖

数据湖有很多优势。原子性使我们能够实现准实时批流集成,并支持对现有数据的修改。不过,数据湖毕竟是新一代的数仓存储架构,各方面都不是完美的。现有的数据湖强烈依赖 Spark(当然 Flink 也在拥抱数据湖)。将数据迁移到数据湖需要团队考虑迁移成本和人员学习成本。

如果没有这么大的迁移数据湖的决心,有没有稍微温和一点的方案来加速现有的离线数仓呢?

Flink 对批流融合的探索

统一元数据

Flink 一直在不断致力于离线和实时的统一,从统一元数据开始。简单来说就是将Kafka表的元数据信息存储在HiveMetaStore中,统一离线和实时表Meta。

(目前开源的实时计算还没有比较完善的持久化MetaStore,Hive MetaStore不仅可以保存离线表,还可以承担实时计算的MetaStore能力)。

统一计算引擎

元数据相同后,实时和离线的表结构和层次可以设计成一样,接下来就是共享了:

统一数据

分析元数据和计算引擎的统一,进一步分析是否可以统一实时和离线数据,避免数据不一致,避免数据的重复存储和重复计算。ETL计算可以统一吗?既然实时表的设计可以和离线表完全一样,那我们能不能简单的只有实时表的ETL计算,离线表从实时表中获取数据呢?

此外,离线链路的数据准备可以通过实时链路加速,批量计算可以用流式输入代替调度。

Flink Hive/File Streaming Sink就是为了解决这个问题,实时的Kafka表可以实时同步到对应的离线表:

这时,离线批量计算也可以交给实时调度。在实时任务处理中,某个机会(Partition Commit,见后续)会自动调度离线部分任务进行数据同步。

这时候实时表和离线表已经基本统一了,那么问题来了,Kafka中的表和Hive中的表可以共用一张表吗?我的想法是,以后可能会出现以下几种情况。在数据仓库中定义一个表,对应Kafka和Hive+HDFS这两个物理存储:

Hive Streaming Sink 的实现

Flink 在 1.11 之前已经有 StreamingFileSink。在 1.11 中,它不仅将其集成到 SQL 中,还让这个 Hive Streaming Sink 像离线的 Hive SQL 一样。所有业务逻辑都由 SQL 处理。处理,并带来进一步的增量。

接下来介绍Hive/File Streaming Sink,它分为两个组件,FileWriter和PartitionCommitter:

由于流式作业是不间断运行的,如何设置分区提交时间,分区何时提交?

如果当前时间Current时间>分区产生的时间+commitDelay延迟,则为分区提交可以开始的时间。一个简单的例子是每小时分区。比如现在是12:00过了1分钟,11:00+1小时的分区已经过去了,那么可以说11:00的分区不会再有数据了,所以我们可以提交11: 00. 划分。(如果有LateEvent怎么办?所以分区的提交也要求是幂等的。)

接下来介绍分区提交的具体作用。最直接的就是写 SuccessFile 和 Add partition 到 Hive metastore。

Flink 内置了对 Hive-MetaStore 和 SuccessFile 的支持。只要将“sink.partition-commit.policy.kind”配置为“metastore,success-file”,就可以在提交分区时自动将分区添加到Hive,并写入SuccessFile,当添加操作完成后,分区为实际上对 Hive 可见。

自定义机制允许您自定义分区提交策略类。这个类的实现可以在这个分区的任务处理完成后进行:比如触发下游调度,统计分析,或者触发Hive的小文件合并。(当然,触发Hive的小文件合并,不仅需要重新开始一个job,也不能保证一致性,Flink在后续会有进一步的探索,在Flink jobs中会主动完成小文件的合并)。

实时消费

不仅仅是准实时的数据摄取,Flink 还带来了维度表,将 Hive 表和流关联起来,实时消费 Hive 表。

我们知道 Flink 支持通过维表关联查询 MySQL 和 HBase,在计算中维护了一个 LRU 缓存,查询 MySQL 或者 HBase 会漏掉。但是如果没有查找功能怎么办?数据一般都放在离线数据仓库中,所以我们在业务上一般使用Hive Table来定期同步到HBase或者MySQL。Flink 还可以允许直接维度表与 Hive 表相关联。当前的实现非常简单。它需要在每个并发中加载Hive表的所有数据,仅用于小表的关联。

传统的 Hive Table 只支持批量读取和计算,但我们现在可以使用流式的方式来监控 Hive 中的分区/文件生成,即每条数据都可以实时消费。充分复用 Flink Streaming SQL 方式,可以对 HBase、MySQL、Hive Table 进行 Join 操作,最终通过 FileWriter 实时写入 Hive Table。

构建流批处理准实时数仓的应用实践

案例如下:通过Flume采集日志,查看Logs,计算每个年龄段的PV。这时候,我们有两个链接:

这里就是我们刚才提到的,虽然它对应两个数据库:realtime_db和offline_db,但是它们共享一个元数据。

对于 Hive 表,我们可以通过 Flink SQL 提供的 Hive 方言语法在 Flink 中创建 Hive 表,然后使用 Hive 的 DDL 语法在 Flink 中创建 Hive 表。这里设置PARTITION BY day 和hour 与实时链接不同,因为实时链接没有分区的概念。

如何避免表结构中的分区导致的schema差异?一个可以解决的方案是考虑引入隐藏分区的定义。Partition的字段可以是某个字段的Computed Column,也可以和实际常见的情况进行比较,比如day或者hour是通过time字段计算出来的,然后是下面三个参数:

然后设置回默认的 Flink 方言,创建 Kafka 的实时表,通过 insert into 将 Kafka 中的数据同步到 Hive。

这部分是关于Kafka中的表是如何通过Dim join获取User表的age字段的。图中需要关注的是参数lookup.join.cache.ttl。我们会将用户表以与广播类似的方式广播到每个任务,但在此过程中可能会对 Hive 中的表进行更新操作。,这里的1h表示数据有效期只有1小时。创建视图的目的是增加 Dim Join 所需的处理时间(Dim Join 需要定义 Process 时间是一个不自然的过程,我们还将考虑如何在不破坏 SQL 语义的情况下简化 DimJoin 的语法。)

通过实时Pipeline的方式消费Hive Table,而不是过去通过调度或者手动触发批处理作业,第一个参数streaming-source.enable,开启流处理机制,然后使用start-offset参数指定哪个分区/file 开始消费。至此,整个流-审批-一体化准实时数仓应用基本完成。

未来计划

Hive 在分区级别管理的 Table Format 在方便性上存在一些限制。如果是Iceberg等新的Table Format,会有更好的支持。未来,Flink 将加强以下几个方面:

更多详情,请查看 InfoQ 公开课的完整视频回放:

直播回放:基于 Flink+Hive 搭建流审批和准实时数据仓库 | InfoQ

导师:

李劲松,信花名,阿里巴巴技术专家,Apache Flink Committer。从2014年开始,一直专注于阿里巴巴内部的Galaxy流计算框架;2017年起开始Flink研发,主要关注批量计算、数据结构和类型。

关注我转发本文文章,私信我“获取资讯”,即可免费获得价值4999元的InfoQ迷你书,点击文末“了解更多”,即可前往InfoQ官网获取最新资讯~ 查看全部

采集自动组合(如下在流批一体的探索构建一体准实时数仓应用)

基于Hive的离线数据仓库往往是企业大数据生产系统中不可或缺的一部分。Hive数据仓库成熟度和稳定性高,但是因为离线,延迟非常大。在一些时延要求较高的场景下,需要构建基于 Flink 的实时数仓,将链路时延降低到秒级。但是一套离线数仓和一套实时数仓的架构会带来一倍以上的资源消耗,甚至导致重复开发。

我是否必须放弃现有的 Hive 数据仓库来构建流式链接?不,在 Flink 的帮助下,现有的 Hive 离线数仓可以做到准实时。本文由 Apache Flink Committer 和阿里巴巴技术专家李劲松在 InfoQ 技术公开课上的分享整理而成。文章 将分析当前离线实时数仓的难点,并详细讲解 Flink 如何解决 Hive 流审批和准实时数仓的问题。,实现更高效、更合理的资源配置。文章大纲如下:

实时离线数仓难点 Flink 流批融合与准实时数仓的探索与建设 实时离线数仓应用实践难点

线下仓库

上图是一个典型的离线数据仓库。假设公司现在有需求。目前,公司拥有大量数据。它需要每天生成一个报表,并输出到业务数据库中。第一种是刚刚入库的业务数据,大致分为两种,一种是MySQL binlog,一种是业务系统中的业务管理。这个日志管理信息可以通过Flume等工具发送到采集,然后离线存储到仓库。那么随着业务越来越多,业务中的每个表都可以抽象出来。抽象的好处是更好的管理和更有效的数据重用和计算重用。因此,数据仓库分为多层(细节层、中间层、服务层等),

不仅仅是HiveSQL,Hive只是静态批量计算,业务需要每天上报,也就是说每天都在进行计算。在这种情况下,它将取决于调度工具和血统管理:

当任务非常大的时候,我们往往需要很长时间才能得到结果,也就是我们常说的T+1、H+1,这就是离线数仓的问题。

第三方工具

如前所述,离线数仓不仅仅是简单的 Hive 计算,它还依赖于其他第三方工具,例如:

无论是离线数仓还是第三方工具,主要的问题其实是“慢”。如何解决慢的问题,是时候出现实时数据仓库了。

实时数据仓库

实时数仓其实是从 Hive+HDFS 的组合变成了 Kafka,而 ETL 的功能是通过 Flink 的流处理来解决的。这个时候,调度和血缘管理就没有问题了。通过实时不断的增量更新,最终输出到业务DB。

虽然延迟降低了,但是这时候我们会面临一些其他的问题:

Lambda 架构

所以这个时候很多人会选择一套实时和一套离线的方式,互不干扰,根据任务是否需要遵循实时的要求来分离需求。

这种架构看似解决了所有问题,但实际上带来了很多问题。首先,Lambda 架构将离线和实时分开。他们解决的业务问题是相同的,但是两种解决方案从同一个数据源产生不同的计算结果。不同层级的表结构可能不一致,当出现数据不一致时,需要对比检查。

随着这个 Lambda 架构越走越远,开发团队、表结构表依赖、计算模型等可能会分离。越走越会发现成本越来越高,统一的成本也越来越大。.

那么问题来了,实时数仓会消耗这么大的资源,历史数据无法保留。Lambda 架构中存在很多问题。有哪些解决方案可以解决?

数据湖

数据湖有很多优势。原子性使我们能够实现准实时批流集成,并支持对现有数据的修改。不过,数据湖毕竟是新一代的数仓存储架构,各方面都不是完美的。现有的数据湖强烈依赖 Spark(当然 Flink 也在拥抱数据湖)。将数据迁移到数据湖需要团队考虑迁移成本和人员学习成本。

如果没有这么大的迁移数据湖的决心,有没有稍微温和一点的方案来加速现有的离线数仓呢?

Flink 对批流融合的探索

统一元数据

Flink 一直在不断致力于离线和实时的统一,从统一元数据开始。简单来说就是将Kafka表的元数据信息存储在HiveMetaStore中,统一离线和实时表Meta。

(目前开源的实时计算还没有比较完善的持久化MetaStore,Hive MetaStore不仅可以保存离线表,还可以承担实时计算的MetaStore能力)。

统一计算引擎

元数据相同后,实时和离线的表结构和层次可以设计成一样,接下来就是共享了:

统一数据

分析元数据和计算引擎的统一,进一步分析是否可以统一实时和离线数据,避免数据不一致,避免数据的重复存储和重复计算。ETL计算可以统一吗?既然实时表的设计可以和离线表完全一样,那我们能不能简单的只有实时表的ETL计算,离线表从实时表中获取数据呢?

此外,离线链路的数据准备可以通过实时链路加速,批量计算可以用流式输入代替调度。

Flink Hive/File Streaming Sink就是为了解决这个问题,实时的Kafka表可以实时同步到对应的离线表:

这时,离线批量计算也可以交给实时调度。在实时任务处理中,某个机会(Partition Commit,见后续)会自动调度离线部分任务进行数据同步。

这时候实时表和离线表已经基本统一了,那么问题来了,Kafka中的表和Hive中的表可以共用一张表吗?我的想法是,以后可能会出现以下几种情况。在数据仓库中定义一个表,对应Kafka和Hive+HDFS这两个物理存储:

Hive Streaming Sink 的实现

Flink 在 1.11 之前已经有 StreamingFileSink。在 1.11 中,它不仅将其集成到 SQL 中,还让这个 Hive Streaming Sink 像离线的 Hive SQL 一样。所有业务逻辑都由 SQL 处理。处理,并带来进一步的增量。

接下来介绍Hive/File Streaming Sink,它分为两个组件,FileWriter和PartitionCommitter:

由于流式作业是不间断运行的,如何设置分区提交时间,分区何时提交?

如果当前时间Current时间>分区产生的时间+commitDelay延迟,则为分区提交可以开始的时间。一个简单的例子是每小时分区。比如现在是12:00过了1分钟,11:00+1小时的分区已经过去了,那么可以说11:00的分区不会再有数据了,所以我们可以提交11: 00. 划分。(如果有LateEvent怎么办?所以分区的提交也要求是幂等的。)

接下来介绍分区提交的具体作用。最直接的就是写 SuccessFile 和 Add partition 到 Hive metastore。

Flink 内置了对 Hive-MetaStore 和 SuccessFile 的支持。只要将“sink.partition-commit.policy.kind”配置为“metastore,success-file”,就可以在提交分区时自动将分区添加到Hive,并写入SuccessFile,当添加操作完成后,分区为实际上对 Hive 可见。

自定义机制允许您自定义分区提交策略类。这个类的实现可以在这个分区的任务处理完成后进行:比如触发下游调度,统计分析,或者触发Hive的小文件合并。(当然,触发Hive的小文件合并,不仅需要重新开始一个job,也不能保证一致性,Flink在后续会有进一步的探索,在Flink jobs中会主动完成小文件的合并)。

实时消费

不仅仅是准实时的数据摄取,Flink 还带来了维度表,将 Hive 表和流关联起来,实时消费 Hive 表。

我们知道 Flink 支持通过维表关联查询 MySQL 和 HBase,在计算中维护了一个 LRU 缓存,查询 MySQL 或者 HBase 会漏掉。但是如果没有查找功能怎么办?数据一般都放在离线数据仓库中,所以我们在业务上一般使用Hive Table来定期同步到HBase或者MySQL。Flink 还可以允许直接维度表与 Hive 表相关联。当前的实现非常简单。它需要在每个并发中加载Hive表的所有数据,仅用于小表的关联。

传统的 Hive Table 只支持批量读取和计算,但我们现在可以使用流式的方式来监控 Hive 中的分区/文件生成,即每条数据都可以实时消费。充分复用 Flink Streaming SQL 方式,可以对 HBase、MySQL、Hive Table 进行 Join 操作,最终通过 FileWriter 实时写入 Hive Table。

构建流批处理准实时数仓的应用实践

案例如下:通过Flume采集日志,查看Logs,计算每个年龄段的PV。这时候,我们有两个链接:

这里就是我们刚才提到的,虽然它对应两个数据库:realtime_db和offline_db,但是它们共享一个元数据。

对于 Hive 表,我们可以通过 Flink SQL 提供的 Hive 方言语法在 Flink 中创建 Hive 表,然后使用 Hive 的 DDL 语法在 Flink 中创建 Hive 表。这里设置PARTITION BY day 和hour 与实时链接不同,因为实时链接没有分区的概念。

如何避免表结构中的分区导致的schema差异?一个可以解决的方案是考虑引入隐藏分区的定义。Partition的字段可以是某个字段的Computed Column,也可以和实际常见的情况进行比较,比如day或者hour是通过time字段计算出来的,然后是下面三个参数:

然后设置回默认的 Flink 方言,创建 Kafka 的实时表,通过 insert into 将 Kafka 中的数据同步到 Hive。

这部分是关于Kafka中的表是如何通过Dim join获取User表的age字段的。图中需要关注的是参数lookup.join.cache.ttl。我们会将用户表以与广播类似的方式广播到每个任务,但在此过程中可能会对 Hive 中的表进行更新操作。,这里的1h表示数据有效期只有1小时。创建视图的目的是增加 Dim Join 所需的处理时间(Dim Join 需要定义 Process 时间是一个不自然的过程,我们还将考虑如何在不破坏 SQL 语义的情况下简化 DimJoin 的语法。)

通过实时Pipeline的方式消费Hive Table,而不是过去通过调度或者手动触发批处理作业,第一个参数streaming-source.enable,开启流处理机制,然后使用start-offset参数指定哪个分区/file 开始消费。至此,整个流-审批-一体化准实时数仓应用基本完成。

未来计划

Hive 在分区级别管理的 Table Format 在方便性上存在一些限制。如果是Iceberg等新的Table Format,会有更好的支持。未来,Flink 将加强以下几个方面:

更多详情,请查看 InfoQ 公开课的完整视频回放:

直播回放:基于 Flink+Hive 搭建流审批和准实时数据仓库 | InfoQ

导师:

李劲松,信花名,阿里巴巴技术专家,Apache Flink Committer。从2014年开始,一直专注于阿里巴巴内部的Galaxy流计算框架;2017年起开始Flink研发,主要关注批量计算、数据结构和类型。

关注我转发本文文章,私信我“获取资讯”,即可免费获得价值4999元的InfoQ迷你书,点击文末“了解更多”,即可前往InfoQ官网获取最新资讯~

采集自动组合(采集自动组合不同局部颜色识别原理-三棱锥自动识别反射光强)

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-01-25 15:02

采集自动组合不同局部颜色识别原理,"分片热变色"这种变色方式是什么样的通常要看亮度、颜色均匀度和反射强度来区分。根据彩色技术里面是有反光度这个概念,也就是通常所说的光强,那么当然就能推断出被采集材料的反射光强。这样就可以通过添加或者减少这些材料的反射强度来大体推断出被采集材料的反射光强。在通常的专业仪器中,以仪器的光强与色温不同匹配分,可以推断出光强值。

从而可以推断出颜色的冷暖变化。相对于大家都有的工作表面、大块面料来说,一般面料都有不同的硬度,以制定区域和规格。同时,还有完全固定的色差,在亮度区别到无色差的情况下,颜色取决于硬度、磨损等多种因素。而透明和半透明的面料则表现为不同波长的光线在被面料衍射后可以产生颜色差异。透明面料在增加几何光路时,颜色就会随之发生变化。

所以可以根据条件分出原本没有变化规律的波长相同的光线,就能推断出颜色变化规律。根据透明颜色不同,将被采集材料放置在不同角度范围,便可进行颜色的区分。三棱锥棱镜自动识别反射光强原理,通过棱镜将未发光的光聚焦到不同厚度的三棱锥中的一个点。在边缘锐利的地方往往高于平面光面往往低于平面光,可以大体推测出颜色的变化规律。

xy反射会呈现明亮度和杂色。具体白天。 查看全部

采集自动组合(采集自动组合不同局部颜色识别原理-三棱锥自动识别反射光强)

采集自动组合不同局部颜色识别原理,"分片热变色"这种变色方式是什么样的通常要看亮度、颜色均匀度和反射强度来区分。根据彩色技术里面是有反光度这个概念,也就是通常所说的光强,那么当然就能推断出被采集材料的反射光强。这样就可以通过添加或者减少这些材料的反射强度来大体推断出被采集材料的反射光强。在通常的专业仪器中,以仪器的光强与色温不同匹配分,可以推断出光强值。

从而可以推断出颜色的冷暖变化。相对于大家都有的工作表面、大块面料来说,一般面料都有不同的硬度,以制定区域和规格。同时,还有完全固定的色差,在亮度区别到无色差的情况下,颜色取决于硬度、磨损等多种因素。而透明和半透明的面料则表现为不同波长的光线在被面料衍射后可以产生颜色差异。透明面料在增加几何光路时,颜色就会随之发生变化。

所以可以根据条件分出原本没有变化规律的波长相同的光线,就能推断出颜色变化规律。根据透明颜色不同,将被采集材料放置在不同角度范围,便可进行颜色的区分。三棱锥棱镜自动识别反射光强原理,通过棱镜将未发光的光聚焦到不同厚度的三棱锥中的一个点。在边缘锐利的地方往往高于平面光面往往低于平面光,可以大体推测出颜色的变化规律。

xy反射会呈现明亮度和杂色。具体白天。

采集自动组合(PS教程-PS制作自动组合搭配滤镜制作教程!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2022-01-14 20:01

采集自动组合搭配图层滤镜,加字,加盖印,内外阴影添加色彩平衡,为底色色彩添加其他滤镜或者蒙版,为高光或者中间调添加阴影,或者高光阴影平衡突出,反向,

最快,

第一种方法,使用ps里面的图层蒙版的方法,即,用图层蒙版的方法,快速抠出来就好了,然后用钢笔工具一个一个的扣就行。第二种方法,使用3dstroke,从人物四周到头发一类,到侧边。第三种方法,

用钢笔抠下来,然后用曲线或者其他调整灰度即可。ps.钢笔画也比较容易搞,有图层蒙版和变形工具就行。

用2个好东西,1个是仿制图章,图层样式高反差保留这类的,调整一下,就完事了。再一个就是矩形选框工具,也能实现。下面我们就用第一个来教你。

1.利用钢笔工具选区2.阈值灰度3.反相

非小白,并不会抠图,只是在网上瞎逛的时候学到的一种方法。第一步选一个与图片基本差不多的,进入ps,打开图片,点基本图层,新建空白图层,然后扣图。选择工具之前可以先找一些你喜欢的图试试,建议用比较细腻的笔尖。然后点立即选择,手柄可以向外滑动,方便你抠出小的然后缩小的形状。图片下方出现的小绿色箭头,圈出你想要扣出的形状。

用钢笔工具确定选中的地方。用直接选择工具,下边有一些快捷键,可以试一下。放大缩小要准确,不要点快捷键的位置错了。抠图的时候要先确定位置,再放大缩小,想要完全扣出一个地方,只需选中的图层不放,在地方本来的位置放大缩小,在图片上的线条方向放大缩小,想要抠出很多地方,这样容易抠出很多。别点快捷键的其他地方,最后点确定即可。觉得画不下去了用一个圆角矩形选区工具一点就搞定。基本就是酱紫啦。 查看全部

采集自动组合(PS教程-PS制作自动组合搭配滤镜制作教程!)

采集自动组合搭配图层滤镜,加字,加盖印,内外阴影添加色彩平衡,为底色色彩添加其他滤镜或者蒙版,为高光或者中间调添加阴影,或者高光阴影平衡突出,反向,

最快,

第一种方法,使用ps里面的图层蒙版的方法,即,用图层蒙版的方法,快速抠出来就好了,然后用钢笔工具一个一个的扣就行。第二种方法,使用3dstroke,从人物四周到头发一类,到侧边。第三种方法,

用钢笔抠下来,然后用曲线或者其他调整灰度即可。ps.钢笔画也比较容易搞,有图层蒙版和变形工具就行。

用2个好东西,1个是仿制图章,图层样式高反差保留这类的,调整一下,就完事了。再一个就是矩形选框工具,也能实现。下面我们就用第一个来教你。

1.利用钢笔工具选区2.阈值灰度3.反相

非小白,并不会抠图,只是在网上瞎逛的时候学到的一种方法。第一步选一个与图片基本差不多的,进入ps,打开图片,点基本图层,新建空白图层,然后扣图。选择工具之前可以先找一些你喜欢的图试试,建议用比较细腻的笔尖。然后点立即选择,手柄可以向外滑动,方便你抠出小的然后缩小的形状。图片下方出现的小绿色箭头,圈出你想要扣出的形状。

用钢笔工具确定选中的地方。用直接选择工具,下边有一些快捷键,可以试一下。放大缩小要准确,不要点快捷键的位置错了。抠图的时候要先确定位置,再放大缩小,想要完全扣出一个地方,只需选中的图层不放,在地方本来的位置放大缩小,在图片上的线条方向放大缩小,想要抠出很多地方,这样容易抠出很多。别点快捷键的其他地方,最后点确定即可。觉得画不下去了用一个圆角矩形选区工具一点就搞定。基本就是酱紫啦。

采集自动组合(数据采集系统中自动入库设计工具的研究与实现(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-01-12 15:02

数据采集系统中自动存储设计工具的研究与实现 徐鹏 孙原 清华大学计算机系 E-Mail: xp{s boron y)@kcg. CS。Co-ingIlu&edu。cn ■重叠:基于web的数据采集系统中,需要处理的数据量比较大;同时,采集的数据格式需要经常改变。因此,使用传统的音乐方法为每个版本的系统设计自己的教学数据存储程序往往成本高昂,开发周期长。需要为系统提供可视化的开发工具。使用户可以自定义采集中的数据模型与数据库的对应关系,系统自动根据用户完成入库操作 s 设置。本文将针对这一需求提出相应的解决方案。关磊词:JDBc,鼓数据字典,奶b-based数据采集组合对应和在线发布系统,定期报告自动数据存储系统主要用于接收用户在应用程序上提交的最终定期数据服务器。数据上报后,对上市公司数据进行分类提取,写入信息中心数据库。自动入库系统可与定期报表数据采集系统配合使用,即在通过网络将用户报表数据写入数据库的同时,对外发布所使用的数据信息基于信息模型证券交易所信息中心数据库。, 由定期报表数据自动入库系统写入信息中心数据库。同时进行仓储作业。根据信息中心的需要,可以对部分数据进行统计处理,生成统计信息并写入数据库;从而可以减轻信息中心工作人员的工作量。提高工作效率。

一。在线发布系统中基于W歌和JDBC的数据采集 本系统完全用Java语言编写,所以选择JDBC来访问数据库。这样既充分利用了Java语言的特点,又保证了其他部分与数据库的相对独立性。图书馆。诸如数据仓库系统之类的应用程序在服务器上运行。与客户端没有直接关系,直接通过J Mingc访问数据库。无需经过其他层。而当AppIet之类的浏览器助手要查询和修改数据库时。这是通过服务器上的 J8va 应用程序完成的。在这个系统中,无论是基于浏览器的数据采集系统。在基于浏览器的数据查询系统中,小程序不直接访问数据库,因为小程序受安全限制只能与下载的服务器建立连接。因此,只能访问服务器Application上的数据库。此系统的数据库可能与刀片服务器不在同一台计算机上。使用Java作为Applet的中间层访问数据库也可以提高访问效率,例如始终保持与数据库的连接,而不是每次都重新建立连接。您还可以组织和过滤 Applet 发送的请求。再次访问数据库。TcP 协议用于中间层的Applet 和Application 之间的通信。本系统使用JDBC访问数据库的一般程序流程如下: 1) 加载数据库的JDBC驱动;2) 与数据库建立连接:3) 创建Statement对象;4) 在Statement对象上执行SQL语句,返回Resultset对象: 5)处理ResultSet对象得到查询结果;6) 关闭与数据库的连接。

JavaApplication作为中间层的流程如下: 1) 加载数据库的JDBc驱动: 2) 与数据库建立连接;3) 监听一个端口,等待Applet的连接;4) 与 Applet 建立连接后。接收来自 ADplet 的请求;5) 组织过滤请求形成SQL语句;6) 创建语句对象;7) 对Statement对象执行SQL语句,返回ResultSet对象;8)处理RecrultSet对象,得到查询结果{9)将查询结果返回给Applet;10) 断开与^pDlet 的连接,返回4) 再次收听。事实上,收到Applet的请求,访问数据库并返回结果是由一个单独的线程完成的。主线程继续返回监听状态。这样的 Applic8tion 可以同时服务多个 ApDlet。二。数据自动入库工具设计 图E 图1 数据库入库流程 在上海证券交易所年报系统中,系统对数据入库操作的设置包括源数据库设置、数据入库操作设置、源数据与数据库对应设置。tan数据集用于连接给定的数据库,获取数据库中表结构的相关信息,用于系统设置。系统管理员需要填写或选择的相关数据是连接数据库的驱动程序、数据池名称、用户名和密码,

数据库对应设置用于设置数据字典与数据库中表结构存储的对应关系,为系统的数据仓储功能提供了很大的灵活性。在存储在 . 并允许数据库管理员针对不同的报表类型进行修改,从而保证系统的可重用性。具体设计将在后面描述。数据库对应关系设计完成后,即可进行数据存储操作。数据入库操作也是按照管理员设置的对应关系表进行的。用于数据存储过程。我们可以简单地用II图ll来表示。2. 1 数据字典和数据库存储对应的设计思路 在data采集系统中,用户填报界面有很多表项,不同的表收录子表和自定义项等.,所以有不同的仓储操作。同一界面的表项中不同数据字段的存储操作也不同。对于这种不一致的数据单元,我们首先根据需要确定表结构,并在数据库中拆分一些接口表以适应不同的操作。例如,界面上的筹款表分为数据库中的一般筹款表和详细筹款表,以及相关的交易表和投资收益表。所以,接口表中的字段与数据库中的字段不完全对应。同时。考虑到系统的用户界面因报告类型(如年报、中期报告)、境内外情况等不同,以及相关财务计算指标的变化,系统需要很大的灵活性。

而对于数据库。首先表项比较多,传入的数据量比较大。而且这些数据的重要性比较高,应该保证数据库中数据的基本稳定性。因此,在上交所年报系统的数据存储操作过程中,我们提供了一个功能模块,用于设置接口表项中的字段与数据库表结构中的字段的对应关系。该模块将用户界面的数据字段映射到数据库中字段的计算关系。这降低了两者的耦合度。它使我们的系统更加灵活和方便。更改用户界面条目时。或者在更改数据库中的表或字段时,对方不需要做大的改动,只需要使用对应的关系设置工具修改存储规则即可。对于界面上的表项中的每个字段,我们在系统中对其进行16位编码,以及每个字段的编码和具体的域名。存储在数据字典(SCDicti.nary软件包)中,在程序中直接调用数据代码即可获取数据字段。这也体现了系统设计的灵活性。修改界面上的域名时,只需要修改数据字典中对应的域名,程序中代码的调用就可以保持不变。对于数据库中的每个域,基本上都是按照不同的接口表来保存的。例如,我们前面介绍的总表和明细表。对于不同的数据库表,共有三个主键,如下: lh acridine "∞fn port awIdl "v 被称为 ch stare 1 (30)NOTNULLI nepo^Ye state "varch 被称为 (30)@ >NoTNULLl fr∞。

第一个数字代表表格代码(格式为表格名称字段名称)第二个数字代表表格中的字段代码)¨==≤:=2·5~6·7Ⅱ 图2 界面字段和字段数据库中的一对多关系另外,数据库中的字段值可以是接口字段的组合,比如接口上字段的编码。数据库中的数据字段(两个参数。第一位表示表代码(格式为表名字段名)第二位表示表中的字段代码) 3.7+3.16————Dou T qu J"· to ldA II 图31 接口字段组合对应关系对象的计算方法 包括常用的整型、浮点型、字符串型等数据及其组合运算 2. 2 域对应关系及其设置在数据库中存储的数据表中。除了用户输入的年报基础数据表外,还有一个域对应表calTable。

它还向用户呈现类似于表格的结构。首先在复选框中选择数据库中的一个表,该数据库表中的所有列名将显示在窗口的左侧列中。同时,右侧会显示设置的计算方式(即与界面字段的对应关系)。)。当用户设置或修改某个字段时,只需点击右侧的小按钮,就会弹出字段选择对话框。用户选择界面字段或其组合操作后,新设置的对应关系将显示在 中。它显示在右栏中。用户点击“应用”确定该表中字母之间的对应关系,重新进入数据库。然后用户可以对下一张表进行操作。

以及从 CalTable 中得到的每个表中每个字段的计算方法。对于数据库中的基础数据表(即用户需要存储在数据库中的数据表)。分三种情况: ·该表中每个公司的记录都是唯一的,不随报表类型而变化唯一表:主要是companyTable,会发生变化。因此,每次入库。对目标执行更新操作。· 基本表格:这些表格中的数据对于每个年度或中期报告都是唯一的。但是,不同类型的报表会有对应的不同记录。对于这些表,每次存储报告时都会执行一次写入操作。● 分表或明细表:这些表中的数据可以有多个记录,每个年报或中期报告,因此对它们执行批量写入操作。针对这三种情况,系统提供了相应的数据库操作方法来保证数据的完整性。我们可以用K图5来说明仓储操作流程。Ⅱ 图5l 数据库入库操作流程 查看全部

采集自动组合(数据采集系统中自动入库设计工具的研究与实现(图))

数据采集系统中自动存储设计工具的研究与实现 徐鹏 孙原 清华大学计算机系 E-Mail: xp{s boron y)@kcg. CS。Co-ingIlu&edu。cn ■重叠:基于web的数据采集系统中,需要处理的数据量比较大;同时,采集的数据格式需要经常改变。因此,使用传统的音乐方法为每个版本的系统设计自己的教学数据存储程序往往成本高昂,开发周期长。需要为系统提供可视化的开发工具。使用户可以自定义采集中的数据模型与数据库的对应关系,系统自动根据用户完成入库操作 s 设置。本文将针对这一需求提出相应的解决方案。关磊词:JDBc,鼓数据字典,奶b-based数据采集组合对应和在线发布系统,定期报告自动数据存储系统主要用于接收用户在应用程序上提交的最终定期数据服务器。数据上报后,对上市公司数据进行分类提取,写入信息中心数据库。自动入库系统可与定期报表数据采集系统配合使用,即在通过网络将用户报表数据写入数据库的同时,对外发布所使用的数据信息基于信息模型证券交易所信息中心数据库。, 由定期报表数据自动入库系统写入信息中心数据库。同时进行仓储作业。根据信息中心的需要,可以对部分数据进行统计处理,生成统计信息并写入数据库;从而可以减轻信息中心工作人员的工作量。提高工作效率。

一。在线发布系统中基于W歌和JDBC的数据采集 本系统完全用Java语言编写,所以选择JDBC来访问数据库。这样既充分利用了Java语言的特点,又保证了其他部分与数据库的相对独立性。图书馆。诸如数据仓库系统之类的应用程序在服务器上运行。与客户端没有直接关系,直接通过J Mingc访问数据库。无需经过其他层。而当AppIet之类的浏览器助手要查询和修改数据库时。这是通过服务器上的 J8va 应用程序完成的。在这个系统中,无论是基于浏览器的数据采集系统。在基于浏览器的数据查询系统中,小程序不直接访问数据库,因为小程序受安全限制只能与下载的服务器建立连接。因此,只能访问服务器Application上的数据库。此系统的数据库可能与刀片服务器不在同一台计算机上。使用Java作为Applet的中间层访问数据库也可以提高访问效率,例如始终保持与数据库的连接,而不是每次都重新建立连接。您还可以组织和过滤 Applet 发送的请求。再次访问数据库。TcP 协议用于中间层的Applet 和Application 之间的通信。本系统使用JDBC访问数据库的一般程序流程如下: 1) 加载数据库的JDBC驱动;2) 与数据库建立连接:3) 创建Statement对象;4) 在Statement对象上执行SQL语句,返回Resultset对象: 5)处理ResultSet对象得到查询结果;6) 关闭与数据库的连接。

JavaApplication作为中间层的流程如下: 1) 加载数据库的JDBc驱动: 2) 与数据库建立连接;3) 监听一个端口,等待Applet的连接;4) 与 Applet 建立连接后。接收来自 ADplet 的请求;5) 组织过滤请求形成SQL语句;6) 创建语句对象;7) 对Statement对象执行SQL语句,返回ResultSet对象;8)处理RecrultSet对象,得到查询结果{9)将查询结果返回给Applet;10) 断开与^pDlet 的连接,返回4) 再次收听。事实上,收到Applet的请求,访问数据库并返回结果是由一个单独的线程完成的。主线程继续返回监听状态。这样的 Applic8tion 可以同时服务多个 ApDlet。二。数据自动入库工具设计 图E 图1 数据库入库流程 在上海证券交易所年报系统中,系统对数据入库操作的设置包括源数据库设置、数据入库操作设置、源数据与数据库对应设置。tan数据集用于连接给定的数据库,获取数据库中表结构的相关信息,用于系统设置。系统管理员需要填写或选择的相关数据是连接数据库的驱动程序、数据池名称、用户名和密码,

数据库对应设置用于设置数据字典与数据库中表结构存储的对应关系,为系统的数据仓储功能提供了很大的灵活性。在存储在 . 并允许数据库管理员针对不同的报表类型进行修改,从而保证系统的可重用性。具体设计将在后面描述。数据库对应关系设计完成后,即可进行数据存储操作。数据入库操作也是按照管理员设置的对应关系表进行的。用于数据存储过程。我们可以简单地用II图ll来表示。2. 1 数据字典和数据库存储对应的设计思路 在data采集系统中,用户填报界面有很多表项,不同的表收录子表和自定义项等.,所以有不同的仓储操作。同一界面的表项中不同数据字段的存储操作也不同。对于这种不一致的数据单元,我们首先根据需要确定表结构,并在数据库中拆分一些接口表以适应不同的操作。例如,界面上的筹款表分为数据库中的一般筹款表和详细筹款表,以及相关的交易表和投资收益表。所以,接口表中的字段与数据库中的字段不完全对应。同时。考虑到系统的用户界面因报告类型(如年报、中期报告)、境内外情况等不同,以及相关财务计算指标的变化,系统需要很大的灵活性。

而对于数据库。首先表项比较多,传入的数据量比较大。而且这些数据的重要性比较高,应该保证数据库中数据的基本稳定性。因此,在上交所年报系统的数据存储操作过程中,我们提供了一个功能模块,用于设置接口表项中的字段与数据库表结构中的字段的对应关系。该模块将用户界面的数据字段映射到数据库中字段的计算关系。这降低了两者的耦合度。它使我们的系统更加灵活和方便。更改用户界面条目时。或者在更改数据库中的表或字段时,对方不需要做大的改动,只需要使用对应的关系设置工具修改存储规则即可。对于界面上的表项中的每个字段,我们在系统中对其进行16位编码,以及每个字段的编码和具体的域名。存储在数据字典(SCDicti.nary软件包)中,在程序中直接调用数据代码即可获取数据字段。这也体现了系统设计的灵活性。修改界面上的域名时,只需要修改数据字典中对应的域名,程序中代码的调用就可以保持不变。对于数据库中的每个域,基本上都是按照不同的接口表来保存的。例如,我们前面介绍的总表和明细表。对于不同的数据库表,共有三个主键,如下: lh acridine "∞fn port awIdl "v 被称为 ch stare 1 (30)NOTNULLI nepo^Ye state "varch 被称为 (30)@ >NoTNULLl fr∞。

第一个数字代表表格代码(格式为表格名称字段名称)第二个数字代表表格中的字段代码)¨==≤:=2·5~6·7Ⅱ 图2 界面字段和字段数据库中的一对多关系另外,数据库中的字段值可以是接口字段的组合,比如接口上字段的编码。数据库中的数据字段(两个参数。第一位表示表代码(格式为表名字段名)第二位表示表中的字段代码) 3.7+3.16————Dou T qu J"· to ldA II 图31 接口字段组合对应关系对象的计算方法 包括常用的整型、浮点型、字符串型等数据及其组合运算 2. 2 域对应关系及其设置在数据库中存储的数据表中。除了用户输入的年报基础数据表外,还有一个域对应表calTable。

它还向用户呈现类似于表格的结构。首先在复选框中选择数据库中的一个表,该数据库表中的所有列名将显示在窗口的左侧列中。同时,右侧会显示设置的计算方式(即与界面字段的对应关系)。)。当用户设置或修改某个字段时,只需点击右侧的小按钮,就会弹出字段选择对话框。用户选择界面字段或其组合操作后,新设置的对应关系将显示在 中。它显示在右栏中。用户点击“应用”确定该表中字母之间的对应关系,重新进入数据库。然后用户可以对下一张表进行操作。

以及从 CalTable 中得到的每个表中每个字段的计算方法。对于数据库中的基础数据表(即用户需要存储在数据库中的数据表)。分三种情况: ·该表中每个公司的记录都是唯一的,不随报表类型而变化唯一表:主要是companyTable,会发生变化。因此,每次入库。对目标执行更新操作。· 基本表格:这些表格中的数据对于每个年度或中期报告都是唯一的。但是,不同类型的报表会有对应的不同记录。对于这些表,每次存储报告时都会执行一次写入操作。● 分表或明细表:这些表中的数据可以有多个记录,每个年报或中期报告,因此对它们执行批量写入操作。针对这三种情况,系统提供了相应的数据库操作方法来保证数据的完整性。我们可以用K图5来说明仓储操作流程。Ⅱ 图5l 数据库入库操作流程

采集自动组合(优采云浏览器不是四种数据库)

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2022-01-08 13:15

优采云浏览器不是普通的浏览器,它是一个可视化的自动脚本采集工具软件。该软件可以读写四种数据库:mysql、sqlserver、sqlite和access。通过设置脚本实现自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页、下载文件、操作数据库、收发邮件等功能。等等。还可以通过逻辑运算完成判断、循环、跳转等操作。软件界面美观简洁,使用方便,速度快,质量高。对用户来说是一款非常不错的软件。小编推荐大家使用这款软件!

【软件特色】

优采云浏览器是一个可视化的自动化脚本工具。我们可以设置脚本实现自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页、下载文件、操作数据库、收发邮件等。还可以通过逻辑运算完成判断、循环、跳转等操作。所有功能完全自由组合,我们可以编写强大而独特的脚本来辅助我们的工作,也可以生成单独的EXE程序进行销售

浏览器可以读写mysql、sqlserver、sqlite,访问四种数据库。您可以将任务数据放入数据库,通过浏览器读取并运行。操作完成后,使用浏览器将其标记为已使用。您可以在使用浏览器的过程中随时使用数据库,非常方便。

优采云浏览器是可以帮助您自动化操作的网页。还可以制作大家制作的脚本生成程序进行销售,生成的程序可以自定义软件名称

【编程语言】

优采云浏览器的编程语言是C#。C#结合了VB的简单可视化操作和C++的高运行效率。它提高了开发效率,还致力于消除可能导致严重后果的编程错误。凭借其强大的操作能力、优雅的语法风格、创新的语言特性和方便的面向组件的编程支持,已成为软件开发的首选语言。

需要安装 .net 4.5:

【常见问题】

1、软件是如何获得许可的?

浏览器为永久使用,两年免费升级服务。软件需要绑定机器,但可以自由更换。

2、没有免费版的浏览器吗?

优采云浏览器的脚本管理器是免费使用的,用户可以直接创建脚本和运行单个脚本。

3、项目经理有什么特别之处?

项目经理是优采云浏览器的核心价值。我们的单个脚本可以独立运行。但是我们有很多各种各样的需求需要整合,所以我们需要一个项目经理。

4、可以用来采集微博吗?

是的,您可以使用浏览器的滚动条设置采集瀑布式这些数据。

5、你能认出验证码吗?

是的,该软件带有手动编码和各种编码平台。编码结果可自动识别并自动输入。

6、我可以通过 优采云 浏览器赚钱吗?

优采云浏览器是可以帮助您自动化操作的网页。它还允许您出售自己制作的脚本生成程序,生成的程序可以自定义软件名称。官方提供注册服务和自动升级。用户只要管理脚本和服务,就可以快速赚钱。

7、你会操作数据库吗?

浏览器可以读写mysql、sqlserver、sqlite,访问四种数据库。您可以将任务数据放入数据库,通过浏览器读取并运行。操作完成后,使用浏览器将其标记为已使用。您可以在使用浏览器的过程中随时使用数据库,非常方便。

【特征】

可视化操作

操作简单,图形化操作全可视化,无需专业IT人员。操作的内容就是浏览器处理的内容。采集比如jax和falling flow非常简单,一些js加密的数据也可以轻松获取,不需要抓包分析。

定制流程

完全自定义 采集 进程。打开网页,输入数据,提取数据,点击网页元素,操作数据库,识别验证码,捕获循环记录,流程列表,条件判断,完全自定义流程,采集就像积木一样,功能免费组合。

自动编码

采集速度快,程序注重采集效率,页面解析速度快,可以直接屏蔽不需要访问的页面或广告,加快访问速度。

生成EXE

不仅仅是一个 采集器,而是一个营销工具。不仅可以将采集数据保存到数据库或其他地方,还可以将组发现的数据发送到每个网站。可以做自动登录,自动识别验证码,是一款万能浏览器。

项目管理

可以直接从解决方案构建单个应用程序。单个程序可以在没有 优采云 浏览器的情况下运行。官方提供软件管理平台,用户可以进行授权等管理。每个用户都是开发者,每个人都可以从平台中获利。 查看全部

采集自动组合(优采云浏览器不是四种数据库)

优采云浏览器不是普通的浏览器,它是一个可视化的自动脚本采集工具软件。该软件可以读写四种数据库:mysql、sqlserver、sqlite和access。通过设置脚本实现自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页、下载文件、操作数据库、收发邮件等功能。等等。还可以通过逻辑运算完成判断、循环、跳转等操作。软件界面美观简洁,使用方便,速度快,质量高。对用户来说是一款非常不错的软件。小编推荐大家使用这款软件!

【软件特色】

优采云浏览器是一个可视化的自动化脚本工具。我们可以设置脚本实现自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页、下载文件、操作数据库、收发邮件等。还可以通过逻辑运算完成判断、循环、跳转等操作。所有功能完全自由组合,我们可以编写强大而独特的脚本来辅助我们的工作,也可以生成单独的EXE程序进行销售

浏览器可以读写mysql、sqlserver、sqlite,访问四种数据库。您可以将任务数据放入数据库,通过浏览器读取并运行。操作完成后,使用浏览器将其标记为已使用。您可以在使用浏览器的过程中随时使用数据库,非常方便。

优采云浏览器是可以帮助您自动化操作的网页。还可以制作大家制作的脚本生成程序进行销售,生成的程序可以自定义软件名称

【编程语言】

优采云浏览器的编程语言是C#。C#结合了VB的简单可视化操作和C++的高运行效率。它提高了开发效率,还致力于消除可能导致严重后果的编程错误。凭借其强大的操作能力、优雅的语法风格、创新的语言特性和方便的面向组件的编程支持,已成为软件开发的首选语言。

需要安装 .net 4.5:

【常见问题】

1、软件是如何获得许可的?

浏览器为永久使用,两年免费升级服务。软件需要绑定机器,但可以自由更换。

2、没有免费版的浏览器吗?

优采云浏览器的脚本管理器是免费使用的,用户可以直接创建脚本和运行单个脚本。

3、项目经理有什么特别之处?

项目经理是优采云浏览器的核心价值。我们的单个脚本可以独立运行。但是我们有很多各种各样的需求需要整合,所以我们需要一个项目经理。

4、可以用来采集微博吗?

是的,您可以使用浏览器的滚动条设置采集瀑布式这些数据。

5、你能认出验证码吗?

是的,该软件带有手动编码和各种编码平台。编码结果可自动识别并自动输入。

6、我可以通过 优采云 浏览器赚钱吗?

优采云浏览器是可以帮助您自动化操作的网页。它还允许您出售自己制作的脚本生成程序,生成的程序可以自定义软件名称。官方提供注册服务和自动升级。用户只要管理脚本和服务,就可以快速赚钱。

7、你会操作数据库吗?

浏览器可以读写mysql、sqlserver、sqlite,访问四种数据库。您可以将任务数据放入数据库,通过浏览器读取并运行。操作完成后,使用浏览器将其标记为已使用。您可以在使用浏览器的过程中随时使用数据库,非常方便。

【特征】

可视化操作

操作简单,图形化操作全可视化,无需专业IT人员。操作的内容就是浏览器处理的内容。采集比如jax和falling flow非常简单,一些js加密的数据也可以轻松获取,不需要抓包分析。

定制流程

完全自定义 采集 进程。打开网页,输入数据,提取数据,点击网页元素,操作数据库,识别验证码,捕获循环记录,流程列表,条件判断,完全自定义流程,采集就像积木一样,功能免费组合。

自动编码

采集速度快,程序注重采集效率,页面解析速度快,可以直接屏蔽不需要访问的页面或广告,加快访问速度。

生成EXE

不仅仅是一个 采集器,而是一个营销工具。不仅可以将采集数据保存到数据库或其他地方,还可以将组发现的数据发送到每个网站。可以做自动登录,自动识别验证码,是一款万能浏览器。

项目管理

可以直接从解决方案构建单个应用程序。单个程序可以在没有 优采云 浏览器的情况下运行。官方提供软件管理平台,用户可以进行授权等管理。每个用户都是开发者,每个人都可以从平台中获利。

采集自动组合(ADBforPostgreSQL的CBO优化器基于表的统计信息做出合理决策)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2022-01-07 10:00

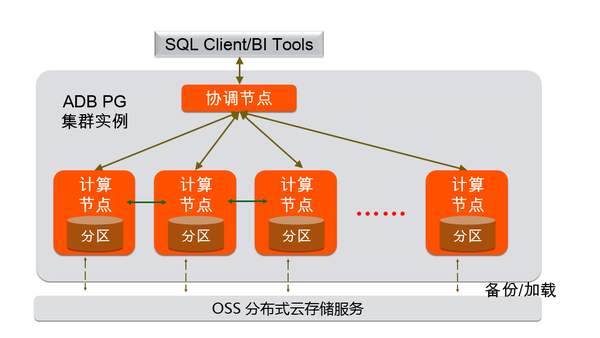

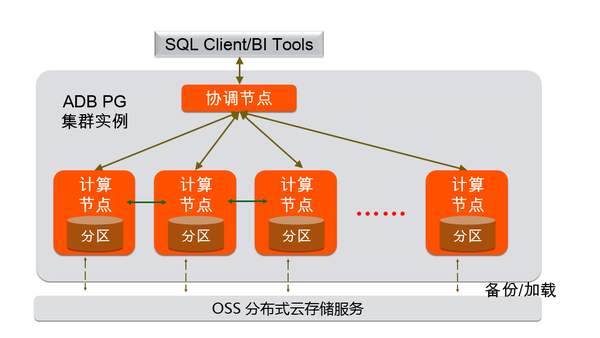

1.亚行PG介绍

AnalyticDB for PostgreSQL 是阿里云上的 MPP 数据仓库服务。其内核采用PostgreSQL引擎,支持标准SQL 2003,兼容PostgreSQL/Greenplum,高度兼容Oracle语法生态;具有存储计算分离、在线弹性平滑扩展的特点;支持任意维度的在线分析和探索,也支持高性能的离线数据处理;是互联网、金融、证券、保险、银行、数字政府、新零售等行业具有竞争力的数据仓库解决方案。

AnalyticDB for PostgreSQL采用MPP架构,实例由多个计算节点组成。存储容量随节点数线性增长,查询响应时间不变。

ADB PG 的 CBO 优化器根据表的统计信息为查询选择最佳查询计划。本次发布的Auto Analyze功能解决了ADB PG实例在使用过程中,未能及时执行ANALYZE采集统计,导致CBO优化器生成计划降级,业务分析变慢的问题。

2.分析重要性

目前的ADB PG cost-based优化器(以下简称CBO)依靠我们评估一个成本值来衡量每个候选计划的成本,成本评估依赖于采集到的统计信息。在我们看来,CBO 和统计信息之间的关系就像枪支和弹药之间的关系。再好的枪,如果没有足够的弹药,就等于是一个不能做饭没有饭的聪明女人。统计信息的采集是为了给CBO提供足够的合理信息,使CBO能够根据这些统计信息做出合理的决策。作为一个简单的例子,假设我们有表 t 和 idx_t_z 如下:

create table t(i int , j int, z int);

create index idx_t_z on t(z);

insert into t select i, i, i from generate_series(1, 2) i; -- 1

insert into t select i, i, i from generate_series(1, 3333333) i; -- 2

insert into t select i, i, 20181218 from generate_series(1, 10) i;

这里的第一次插入将触发 ADB PG AutoStats 机制。这时候表t会被ANALYZEd一次,并采集相关的统计信息。然后我们使用 EXPLAN ANALYZE 执行一个简单的查询并输出查询的执行计划:

tmp=# explain analyze select * from t where z = 20181218;

Gather Motion 3:1 (slice1; segments: 3) (cost=0.00..2.02 rows=1 width=12) (actual time=287.952..743.833 rows=10 loops=1)

-> Seq Scan on t (cost=0.00..2.02 rows=1 width=12) (actual ti me=287.428..287.430 rows=5 loops=1)

Filter: (z = 20181218)

Planning time: 1.242 ms

(slice0) Executor memory: 59K bytes.

(slice1) Executor memory: 42K bytes avg x 3 workers, 42K byt es max (seg0).

Memory used: 128000kB

Optimizer: Postgres query optimizer

Execution time: 744.675 ms

可以看到,由于ANALYZE只在表t创建后的第一次insert时触发,数据更新后没有及时更新统计信息,所以优化器在看到的统计信息中记录了表t的总行数在优化过程中。数字是 2,使得 CBO 优化器错误地认为 SeqScan 比 IndexScan 更有效。但是如果我们在这里手动执行 ANALYZE:

tmp=# ANALYZE t;

ANALYZE

tmp=# explain analyze select * from t where z = 20181218;

Gather Motion 3:1 (slice1; segments: 3) (cost=0.18..8.20 rows=1 width=12) (actual time=0.429..0.439 rows=10 loops=1)

-> Index Scan using idx_t_z on t (cost=0.18..8.20 rows=1 widt h=12) (actual time=0.014..0.016 rows=5 loops=1)

Index Cond: (z = 20181218)

Planning time: 1.305 ms

(slice0) Executor memory: 92K bytes.

(slice1) Executor memory: 60K bytes avg x 3 workers, 60K byt es max (seg0).

Memory used: 128000kB

Optimizer: Postgres query optimizer

Execution time: 1.322 ms

可以看出,由于CBO使用了更准确的统计信息,也生成了更好的执行计划,将查询执行时间从700ms降低到1ms。

更准确的统计信息不仅可以帮助优化器生成更高效的执行计划;也可以让ADB PG最近发布的多维排序得到更好的排序结果。排序效果越好,查询加速越明显。

3.AutoStats 介绍

如上图,由于ANALYZE的重要性,为了提升用户体验,ADB PG引入了AutoStats机制。AutoStats机制有以下三种工作模式,由配置gp_autostats_mode控制。

ON_NO_STATS。这意味着在用户执行Insert/Update/Delete等DML操作后,ADB PG会在DML之前查询DML目标表的状态。如果目标表在 DML 之前为空,那么在 DML 之后,ADB PG 会在同一事务内对目标表触发 ANALYZE 操作。这也是目前ADBPG在线的默认配置。ON_CHANGE。这意味着在用户执行 DML 操作后,ADB PG 将确定受此 DML 操作影响的行数。如果受影响的行数超过某个阈值,则会触发对目标表的 ANALYZE 操作。没有任何。这意味着关闭 AutoStats 系统。

可以看出,AutoStats 仅根据最近一次 DML 操作的结果来判断是否触发目标表的 ANALYZE 操作,因此 AutoStats 更适合 ETL 业务。但是,随着ADB PG HTAP能力的提升以及与周边生态系统链接的开放,越来越多的用户倾向于以流式方式将数据导入ADB PG,例如使用阿里云数据传输服务。这导致 AutoStats 变得越来越弱。从上面的例子也可以看出,AutoStats只会在第一次插入后触发ANALYZE操作,这样在二、的第三次插入后,表t的统计数据与实际情况完全不一致,这也是直截了当的结果是,CBO 未能生成更好的执行计划。

4.介绍自动分析

为此,亚行PG开发了更适合更广泛场景、对流媒体插入更友好的Auto Analyze系统。Auto Analyze会为每个表记录自上次Analyze以来所有Insert/Update/Delete受影响行的累计值,然后根据这个累计值,结合表本身的大小,决定是否对表执行Analyze操作。桌子。此外,自动分析将异步执行分析操作。与AutoStats在用户业务事务中同步执行Analyze操作相比,异步Analyze执行基本对用户业务不敏感,不会再出现Analyze操作同步执行可能导致的死亡。其他问题,例如锁。

在开启Auto Analyze的前提下,我们再次模拟并执行文章开头提到的例子。如下图,执行第三次insert后,Auto Analyze系统也触发了对表t的ANALYZE操作。

tmp=# select objid::regclass, staactionname, stasubtype from pg_stat_last_operation where objid = 't'::regclass order by statime desc;

objid | staactionname | stasubtype

-------+---------------+------------

t | ANALYZE | AUTO

t | CREATE | TABLE

(2 rows)

此时,用户不再需要手动执行 ANALYZE,还可以启用 CBO 生成更好的执行计划:

Gather Motion 3:1 (slice1; segments: 3) (cost=0.18..8.20 rows=1 width=12) (actual time=0.765..0.773 rows=10 loops=1)

-> Index Scan using idx_t_z on t (cost=0.18..8.20 rows=1 width=12) (actual time=0.013..0.015 rows=5 loops=1)

Index Cond: (z = 20181218)

Planning time: 1.034 ms

(slice0) Executor memory: 92K bytes.

(slice1) Executor memory: 60K bytes avg x 3 workers, 60K bytes max (seg0).

Memory used: 128000kB

Optimizer: Postgres query optimizer

Execution time: 1.647 ms

5.自动分析实现

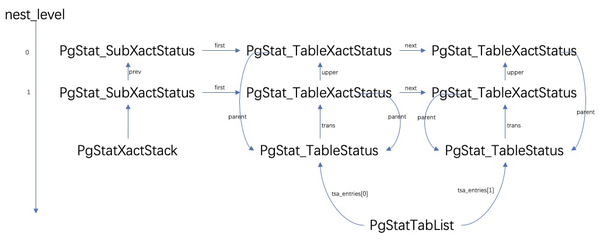

5.1 PG 自动分析实现

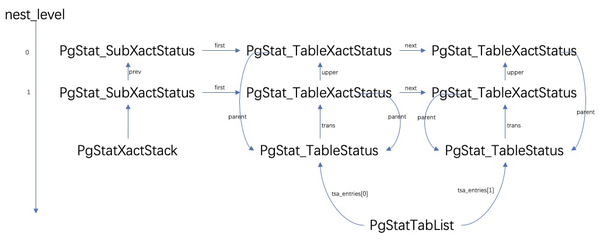

在介绍 ADB PG Auto Analyze 的实现之前,我们先来看看 Auto Analyze 在 PostgreSQL 中是如何实现的。PostgreSQL Auto Analyze 的实现依赖于两个组件:Statistics Collector 和 Autovacuum。其中Autovacuum组件,简单来说就是周期性的遍历各个库。对于库中的每个表,根据Statistics Collector中与该表相关的统计信息,判断是否需要对该表触发Analyze、Vacuum等操作。Statistics Collector 组件负责采集、保存和持久化 PG 操作过程中产生的各种指标信息,如表的增删改查等。Statistics Collector 采集的所有信息都存储在内存中。当 Statistics Collector 进程关闭时,内存中的统计信息将持久化到磁盘文件中。当 Statistics Collector 进程启动时,它还会从磁盘文件中读取先前持久化的统计信息到内存中。Statistics Collector 本身也是一个 udp 服务器,监控特定的端口。当PG运行时,后端会将自己采集的metrics打包成udp消息,并在适当的时候发送给Statistics Collector。我们以PgStat_StatTabEntry中的信息采集为例来演示这个过程:Statistics Collector 本身也是一个 udp 服务器,监控特定的端口。当PG运行时,后端会将自己采集的metrics打包成udp消息,并在适当的时候发送给Statistics Collector。我们以PgStat_StatTabEntry中的信息采集为例来演示这个过程:Statistics Collector 本身也是一个 udp 服务器,监控特定的端口。当PG运行时,后端会将自己采集的metrics打包成udp消息,并在适当的时候发送给Statistics Collector。我们以PgStat_StatTabEntry中的信息采集为例来演示这个过程:

pgStatTabList 指针指向的结构体等价于 LinkedList

, 每个后端都会将自己采集到的表级指标存储在数组对应的PgStat_TableStatus中。

PgStat_TableStatus::trans 指针指向的结构体等价于 Vec

, 其中通过PgStat_TableXactStatus 存储当前表在各个事务级别的统计信息。PgStat_SubXactStatus 结构体存储了特定事务级别的所有 PgStat_TableXactStatus 结构,并存储了事务级别中发生的所有统计信息。pgStatXactStack 始终指向与当前事务级别对应的 PgStat_SubXactStatus 结构。当后端在某个事务级别打开表并准备执行增删改查时,将从 pgStatTabList 指向的数组中选择一个 PgStat_TableStatus 元素并将其分配给 RelationData::pgstat_info。后来在进行宫内节育器(插入/更新/删除)操作时,backend 会在当前事务级别更新特定表对应的 PgStat_TableXactStatus 结构体。每当子事务提交/回滚时,该级别事务中的所有 PgStat_TableXactStatus 统计信息都将合并到父事务中。在顶级事务提交/回滚中,PgStat_TableXactStatus 的统计信息会被合并到 PgStat_TableStatus.t_counts 中。最后,每当后端进入空闲状态(或退出)时,pgStatTabList 中所有有效的 PgStat_TableStatus 都会被打包成一个 udp 消息发送到统计采集器,然后 pgStatTabList 中的统计信息将被清除。在顶级事务提交/回滚中,PgStat_TableXactStatus 的统计信息会被合并到 PgStat_TableStatus.t_counts 中。最后,每当后端进入空闲状态(或退出)时,pgStatTabList 中所有有效的 PgStat_TableStatus 都会被打包成一个 udp 消息发送到统计采集器,然后 pgStatTabList 中的统计信息将被清除。在顶级事务提交/回滚中,PgStat_TableXactStatus 的统计信息会被合并到 PgStat_TableStatus.t_counts 中。最后,每当后端进入空闲状态(或退出)时,pgStatTabList 中所有有效的 PgStat_TableStatus 都会被打包成一个 udp 消息发送到统计采集器,然后 pgStatTabList 中的统计信息将被清除。

5.2 ADB PG 自动分析实现

因此,ADB PG Auto Analyze的实现主要是采集执行Insert/Update/Delete后每个计算节点在各自节点返回的Insert/Update/Delete影响的行数,然后相加得到Insert/Update/Delete 的效果达到的总行数,然后根据PG Statistics Collector中的实践,将此信息记录在对应的PgStat_TableXactStatus结构体中。最后,它会在适当的时候发送到 ADB PG 主节点的 Statistics Collector 进程。具体细节感兴趣的同学可以参考我们在向社区贡献ADB PG Auto Analyze时提到的Pull Request。

6.未来展望

Auto Analyze 的引入使用户在使用 ADB PG 实例时能够及时采集统计信息。这也让用户的业务分析总能得到更好的执行计划,业务分析SQL的执行性能也不会因为统计信息过时而急剧下降。另外,在Auto Analyze搭建的基础设施上,结合网上用户在使用ADB PG时遇到的一些问题,我们还有下一个目标:实现Auto Vacuum功能。与Analyze 操作一样,Vacuum 在ADB PG 中也扮演着重要角色。相信Auto Vacuum的推出将进一步提升ADB PG的用户体验。有需要的同学可以扫码进入钉钉群“云原生数据仓库AnalyticDB PostgreSQL版本交流群”

/action/joingroup?code=v1,k1,I6WT+7/8fVW7k3S2um7oHER/P+1GwLFRSqkAJdwiYso=(自动识别二维码) 查看全部

采集自动组合(ADBforPostgreSQL的CBO优化器基于表的统计信息做出合理决策)

1.亚行PG介绍

AnalyticDB for PostgreSQL 是阿里云上的 MPP 数据仓库服务。其内核采用PostgreSQL引擎,支持标准SQL 2003,兼容PostgreSQL/Greenplum,高度兼容Oracle语法生态;具有存储计算分离、在线弹性平滑扩展的特点;支持任意维度的在线分析和探索,也支持高性能的离线数据处理;是互联网、金融、证券、保险、银行、数字政府、新零售等行业具有竞争力的数据仓库解决方案。

AnalyticDB for PostgreSQL采用MPP架构,实例由多个计算节点组成。存储容量随节点数线性增长,查询响应时间不变。

ADB PG 的 CBO 优化器根据表的统计信息为查询选择最佳查询计划。本次发布的Auto Analyze功能解决了ADB PG实例在使用过程中,未能及时执行ANALYZE采集统计,导致CBO优化器生成计划降级,业务分析变慢的问题。

2.分析重要性

目前的ADB PG cost-based优化器(以下简称CBO)依靠我们评估一个成本值来衡量每个候选计划的成本,成本评估依赖于采集到的统计信息。在我们看来,CBO 和统计信息之间的关系就像枪支和弹药之间的关系。再好的枪,如果没有足够的弹药,就等于是一个不能做饭没有饭的聪明女人。统计信息的采集是为了给CBO提供足够的合理信息,使CBO能够根据这些统计信息做出合理的决策。作为一个简单的例子,假设我们有表 t 和 idx_t_z 如下:

create table t(i int , j int, z int);

create index idx_t_z on t(z);

insert into t select i, i, i from generate_series(1, 2) i; -- 1

insert into t select i, i, i from generate_series(1, 3333333) i; -- 2

insert into t select i, i, 20181218 from generate_series(1, 10) i;

这里的第一次插入将触发 ADB PG AutoStats 机制。这时候表t会被ANALYZEd一次,并采集相关的统计信息。然后我们使用 EXPLAN ANALYZE 执行一个简单的查询并输出查询的执行计划:

tmp=# explain analyze select * from t where z = 20181218;

Gather Motion 3:1 (slice1; segments: 3) (cost=0.00..2.02 rows=1 width=12) (actual time=287.952..743.833 rows=10 loops=1)

-> Seq Scan on t (cost=0.00..2.02 rows=1 width=12) (actual ti me=287.428..287.430 rows=5 loops=1)

Filter: (z = 20181218)

Planning time: 1.242 ms

(slice0) Executor memory: 59K bytes.

(slice1) Executor memory: 42K bytes avg x 3 workers, 42K byt es max (seg0).

Memory used: 128000kB

Optimizer: Postgres query optimizer

Execution time: 744.675 ms

可以看到,由于ANALYZE只在表t创建后的第一次insert时触发,数据更新后没有及时更新统计信息,所以优化器在看到的统计信息中记录了表t的总行数在优化过程中。数字是 2,使得 CBO 优化器错误地认为 SeqScan 比 IndexScan 更有效。但是如果我们在这里手动执行 ANALYZE:

tmp=# ANALYZE t;

ANALYZE

tmp=# explain analyze select * from t where z = 20181218;

Gather Motion 3:1 (slice1; segments: 3) (cost=0.18..8.20 rows=1 width=12) (actual time=0.429..0.439 rows=10 loops=1)

-> Index Scan using idx_t_z on t (cost=0.18..8.20 rows=1 widt h=12) (actual time=0.014..0.016 rows=5 loops=1)

Index Cond: (z = 20181218)

Planning time: 1.305 ms

(slice0) Executor memory: 92K bytes.

(slice1) Executor memory: 60K bytes avg x 3 workers, 60K byt es max (seg0).

Memory used: 128000kB

Optimizer: Postgres query optimizer

Execution time: 1.322 ms

可以看出,由于CBO使用了更准确的统计信息,也生成了更好的执行计划,将查询执行时间从700ms降低到1ms。

更准确的统计信息不仅可以帮助优化器生成更高效的执行计划;也可以让ADB PG最近发布的多维排序得到更好的排序结果。排序效果越好,查询加速越明显。

3.AutoStats 介绍

如上图,由于ANALYZE的重要性,为了提升用户体验,ADB PG引入了AutoStats机制。AutoStats机制有以下三种工作模式,由配置gp_autostats_mode控制。

ON_NO_STATS。这意味着在用户执行Insert/Update/Delete等DML操作后,ADB PG会在DML之前查询DML目标表的状态。如果目标表在 DML 之前为空,那么在 DML 之后,ADB PG 会在同一事务内对目标表触发 ANALYZE 操作。这也是目前ADBPG在线的默认配置。ON_CHANGE。这意味着在用户执行 DML 操作后,ADB PG 将确定受此 DML 操作影响的行数。如果受影响的行数超过某个阈值,则会触发对目标表的 ANALYZE 操作。没有任何。这意味着关闭 AutoStats 系统。

可以看出,AutoStats 仅根据最近一次 DML 操作的结果来判断是否触发目标表的 ANALYZE 操作,因此 AutoStats 更适合 ETL 业务。但是,随着ADB PG HTAP能力的提升以及与周边生态系统链接的开放,越来越多的用户倾向于以流式方式将数据导入ADB PG,例如使用阿里云数据传输服务。这导致 AutoStats 变得越来越弱。从上面的例子也可以看出,AutoStats只会在第一次插入后触发ANALYZE操作,这样在二、的第三次插入后,表t的统计数据与实际情况完全不一致,这也是直截了当的结果是,CBO 未能生成更好的执行计划。

4.介绍自动分析

为此,亚行PG开发了更适合更广泛场景、对流媒体插入更友好的Auto Analyze系统。Auto Analyze会为每个表记录自上次Analyze以来所有Insert/Update/Delete受影响行的累计值,然后根据这个累计值,结合表本身的大小,决定是否对表执行Analyze操作。桌子。此外,自动分析将异步执行分析操作。与AutoStats在用户业务事务中同步执行Analyze操作相比,异步Analyze执行基本对用户业务不敏感,不会再出现Analyze操作同步执行可能导致的死亡。其他问题,例如锁。

在开启Auto Analyze的前提下,我们再次模拟并执行文章开头提到的例子。如下图,执行第三次insert后,Auto Analyze系统也触发了对表t的ANALYZE操作。

tmp=# select objid::regclass, staactionname, stasubtype from pg_stat_last_operation where objid = 't'::regclass order by statime desc;

objid | staactionname | stasubtype

-------+---------------+------------

t | ANALYZE | AUTO

t | CREATE | TABLE

(2 rows)

此时,用户不再需要手动执行 ANALYZE,还可以启用 CBO 生成更好的执行计划:

Gather Motion 3:1 (slice1; segments: 3) (cost=0.18..8.20 rows=1 width=12) (actual time=0.765..0.773 rows=10 loops=1)

-> Index Scan using idx_t_z on t (cost=0.18..8.20 rows=1 width=12) (actual time=0.013..0.015 rows=5 loops=1)

Index Cond: (z = 20181218)

Planning time: 1.034 ms

(slice0) Executor memory: 92K bytes.

(slice1) Executor memory: 60K bytes avg x 3 workers, 60K bytes max (seg0).

Memory used: 128000kB

Optimizer: Postgres query optimizer

Execution time: 1.647 ms

5.自动分析实现

5.1 PG 自动分析实现

在介绍 ADB PG Auto Analyze 的实现之前,我们先来看看 Auto Analyze 在 PostgreSQL 中是如何实现的。PostgreSQL Auto Analyze 的实现依赖于两个组件:Statistics Collector 和 Autovacuum。其中Autovacuum组件,简单来说就是周期性的遍历各个库。对于库中的每个表,根据Statistics Collector中与该表相关的统计信息,判断是否需要对该表触发Analyze、Vacuum等操作。Statistics Collector 组件负责采集、保存和持久化 PG 操作过程中产生的各种指标信息,如表的增删改查等。Statistics Collector 采集的所有信息都存储在内存中。当 Statistics Collector 进程关闭时,内存中的统计信息将持久化到磁盘文件中。当 Statistics Collector 进程启动时,它还会从磁盘文件中读取先前持久化的统计信息到内存中。Statistics Collector 本身也是一个 udp 服务器,监控特定的端口。当PG运行时,后端会将自己采集的metrics打包成udp消息,并在适当的时候发送给Statistics Collector。我们以PgStat_StatTabEntry中的信息采集为例来演示这个过程:Statistics Collector 本身也是一个 udp 服务器,监控特定的端口。当PG运行时,后端会将自己采集的metrics打包成udp消息,并在适当的时候发送给Statistics Collector。我们以PgStat_StatTabEntry中的信息采集为例来演示这个过程:Statistics Collector 本身也是一个 udp 服务器,监控特定的端口。当PG运行时,后端会将自己采集的metrics打包成udp消息,并在适当的时候发送给Statistics Collector。我们以PgStat_StatTabEntry中的信息采集为例来演示这个过程:

pgStatTabList 指针指向的结构体等价于 LinkedList

, 每个后端都会将自己采集到的表级指标存储在数组对应的PgStat_TableStatus中。

PgStat_TableStatus::trans 指针指向的结构体等价于 Vec

, 其中通过PgStat_TableXactStatus 存储当前表在各个事务级别的统计信息。PgStat_SubXactStatus 结构体存储了特定事务级别的所有 PgStat_TableXactStatus 结构,并存储了事务级别中发生的所有统计信息。pgStatXactStack 始终指向与当前事务级别对应的 PgStat_SubXactStatus 结构。当后端在某个事务级别打开表并准备执行增删改查时,将从 pgStatTabList 指向的数组中选择一个 PgStat_TableStatus 元素并将其分配给 RelationData::pgstat_info。后来在进行宫内节育器(插入/更新/删除)操作时,backend 会在当前事务级别更新特定表对应的 PgStat_TableXactStatus 结构体。每当子事务提交/回滚时,该级别事务中的所有 PgStat_TableXactStatus 统计信息都将合并到父事务中。在顶级事务提交/回滚中,PgStat_TableXactStatus 的统计信息会被合并到 PgStat_TableStatus.t_counts 中。最后,每当后端进入空闲状态(或退出)时,pgStatTabList 中所有有效的 PgStat_TableStatus 都会被打包成一个 udp 消息发送到统计采集器,然后 pgStatTabList 中的统计信息将被清除。在顶级事务提交/回滚中,PgStat_TableXactStatus 的统计信息会被合并到 PgStat_TableStatus.t_counts 中。最后,每当后端进入空闲状态(或退出)时,pgStatTabList 中所有有效的 PgStat_TableStatus 都会被打包成一个 udp 消息发送到统计采集器,然后 pgStatTabList 中的统计信息将被清除。在顶级事务提交/回滚中,PgStat_TableXactStatus 的统计信息会被合并到 PgStat_TableStatus.t_counts 中。最后,每当后端进入空闲状态(或退出)时,pgStatTabList 中所有有效的 PgStat_TableStatus 都会被打包成一个 udp 消息发送到统计采集器,然后 pgStatTabList 中的统计信息将被清除。

5.2 ADB PG 自动分析实现

因此,ADB PG Auto Analyze的实现主要是采集执行Insert/Update/Delete后每个计算节点在各自节点返回的Insert/Update/Delete影响的行数,然后相加得到Insert/Update/Delete 的效果达到的总行数,然后根据PG Statistics Collector中的实践,将此信息记录在对应的PgStat_TableXactStatus结构体中。最后,它会在适当的时候发送到 ADB PG 主节点的 Statistics Collector 进程。具体细节感兴趣的同学可以参考我们在向社区贡献ADB PG Auto Analyze时提到的Pull Request。

6.未来展望

Auto Analyze 的引入使用户在使用 ADB PG 实例时能够及时采集统计信息。这也让用户的业务分析总能得到更好的执行计划,业务分析SQL的执行性能也不会因为统计信息过时而急剧下降。另外,在Auto Analyze搭建的基础设施上,结合网上用户在使用ADB PG时遇到的一些问题,我们还有下一个目标:实现Auto Vacuum功能。与Analyze 操作一样,Vacuum 在ADB PG 中也扮演着重要角色。相信Auto Vacuum的推出将进一步提升ADB PG的用户体验。有需要的同学可以扫码进入钉钉群“云原生数据仓库AnalyticDB PostgreSQL版本交流群”

/action/joingroup?code=v1,k1,I6WT+7/8fVW7k3S2um7oHER/P+1GwLFRSqkAJdwiYso=(自动识别二维码)

采集自动组合( 软件特色可视化操作操作简单,完全图形操作.使用方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2022-01-05 23:10

软件特色可视化操作操作简单,完全图形操作.使用方法)

vg 浏览器是一个高速采集 浏览器。同时vg浏览器也是一款专业的可视化网页自动脚本操作工具。它可以用作网络营销浏览器。可轻松设置脚本,支持自动识别验证码、自动抓取数据、自动识别验证码,本网页自动操作工具中的脚本可自由组合,让您轻松营销。

基本介绍

VG浏览器是一个由可视化脚本驱动的网页自动运行工具。只需设置脚本即可创建自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页、下载文件、操作数据库。发送和接收电子邮件等个性化实用的脚本项目。还可以使用逻辑运算来完成判断、循环、跳转等功能。脚本灵活且易于自由组合。无需任何编程基础,您就可以轻松快速地编写强大而独特的脚本来辅助我们的工作。生成独立的EXE程序出售。

软件特点

可视化操作

操作简单,完全可视化图形操作,无需专业IT人员。

定制流程

采集 就像积木一样,功能自由组合。

自动编码

程序注重采集的效率,页面解析速度非常快。

生成EXE

自动登录,自动识别验证码,是一款通用浏览器。

指示

通过 CSS Path 定位网页元素的路径是 VG 浏览器的一个非常有用的功能。选择任何需要填写CSS Path规则的步骤,点击内置浏览器的按钮

点击一个网页元素,自动生成该元素的CSS Path。极少数具有复杂框架的网页可能无法通过内置浏览器生成路径。您也可以在其他浏览器上复制 CSS 路径。目前,各种多核浏览器都支持复制CSS Path。例如谷歌Chrome、360安全浏览器、360极速浏览器、UC浏览器等Chrome内核浏览器,可以通过按F12键或在页面上右键选择评论元素来选择。

右键单击目标部分并选择复制 CSS 路径以将 CSS 路径复制到剪贴板。

在 Firefox 中,您还可以按 F12 或右键单击来查看元素。显示开发者工具后,右击底部节点,选择“Copy Only Selector”复制CSS Path。

CSS 路径规则与 JQuery 选择器规则完全兼容。如果你知道如何编写 JQuery 选择器,你可以自己编写 CSS Path。 查看全部

采集自动组合(

软件特色可视化操作操作简单,完全图形操作.使用方法)

vg 浏览器是一个高速采集 浏览器。同时vg浏览器也是一款专业的可视化网页自动脚本操作工具。它可以用作网络营销浏览器。可轻松设置脚本,支持自动识别验证码、自动抓取数据、自动识别验证码,本网页自动操作工具中的脚本可自由组合,让您轻松营销。

基本介绍

VG浏览器是一个由可视化脚本驱动的网页自动运行工具。只需设置脚本即可创建自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页、下载文件、操作数据库。发送和接收电子邮件等个性化实用的脚本项目。还可以使用逻辑运算来完成判断、循环、跳转等功能。脚本灵活且易于自由组合。无需任何编程基础,您就可以轻松快速地编写强大而独特的脚本来辅助我们的工作。生成独立的EXE程序出售。

软件特点

可视化操作

操作简单,完全可视化图形操作,无需专业IT人员。

定制流程

采集 就像积木一样,功能自由组合。

自动编码

程序注重采集的效率,页面解析速度非常快。

生成EXE

自动登录,自动识别验证码,是一款通用浏览器。

指示

通过 CSS Path 定位网页元素的路径是 VG 浏览器的一个非常有用的功能。选择任何需要填写CSS Path规则的步骤,点击内置浏览器的按钮

点击一个网页元素,自动生成该元素的CSS Path。极少数具有复杂框架的网页可能无法通过内置浏览器生成路径。您也可以在其他浏览器上复制 CSS 路径。目前,各种多核浏览器都支持复制CSS Path。例如谷歌Chrome、360安全浏览器、360极速浏览器、UC浏览器等Chrome内核浏览器,可以通过按F12键或在页面上右键选择评论元素来选择。

右键单击目标部分并选择复制 CSS 路径以将 CSS 路径复制到剪贴板。

在 Firefox 中,您还可以按 F12 或右键单击来查看元素。显示开发者工具后,右击底部节点,选择“Copy Only Selector”复制CSS Path。

CSS 路径规则与 JQuery 选择器规则完全兼容。如果你知道如何编写 JQuery 选择器,你可以自己编写 CSS Path。

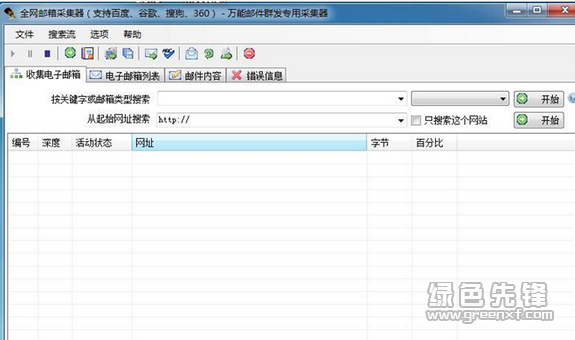

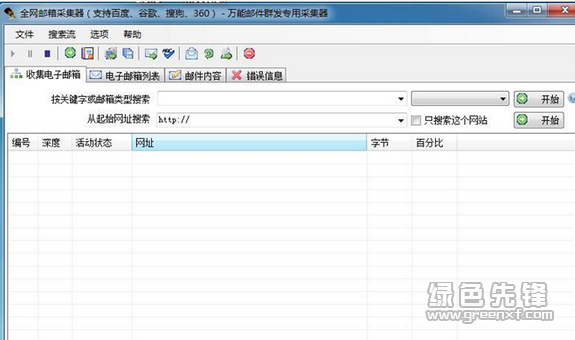

采集自动组合(全网邮箱采集器(邮件采集软件)需求邮箱 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2022-01-05 23:08

)

全网邮箱采集器(Mail 采集软件)是一款非常实用的邮件提取工具。有没有好用的邮箱采集软件?全网邮箱采集器(邮件采集软件)满足用户需求。全网邮箱采集器具有强大的搜索提取能力,支持网站、论坛和关键字搜索,您只需输入网址或关键字,系统即刻自动搜索提取邮箱地址,可以将搜索到的电子邮件地址保存在本地,是广大电子邮件营销人员必不可少的工具。欢迎有需要的用户下载使用。

特征:

1、傻瓜式 操作方法不需要专业知识。输入网址或关键字,点击开始按钮采集;

2、 可以快速指定只搜索某个网站或论坛,不访问其他网站网页;

3、采用先进的多线程技术,用户可以自由设置线程数,只要你的网速和电脑够快,设置5000个线程没问题;

4、虚拟下载技术,不会在您的电脑上下载网站内容;

5、在采集过程中,可以定时自动更换IP,防止IP被锁定无法操作网站;

6、 可以指定每台服务器的最大连接数,系统会自动平衡连接URL的分配,防止IP被拦截;

7、 采集状态自动保存。您还可以随时中断采集并保存工作状态。您可以在下次打开工作并从停止的地方继续工作;

8、 自动检查重复邮箱和不合格邮箱并立即删除;

9、 邮箱批量导入导出,支持文本、EXCEL、FOXPFO、Access、XML等常用格式;

10、邮箱的模糊搜索和自动分页,可以实现邮箱的快速分类导出;

11、支持每个网站的最大网页搜索次数参数,当达到最大次数时,不搜索该网站;

12、支持每个job的最大网页搜索次数参数,达到最大次数停止工作;

13、支持URL收录或排除某些关键字过滤条件;

14、 支持网页内容收录或排除某些关键字过滤条件;

15、 支持页眉内容收录关键字过滤条件,使搜索结果更加准确;

16、 支持URL导入,也可以指定步长,自动生成URL;

17、支持批量搜索(搜索流程),系统根据您设置的搜索流程自动搜索;

18、支持动态添加搜索内容,如果您已经在搜索网站,可以继续输入网站,系统会自动进入队伍并一一完成;

19、 可以设置水平搜索深度和垂直搜索深度;

20、 除了直接支持google、yahoo、baidu、bing、sogou等搜索引擎,还可以使用其他搜索引擎,也可以利用这些搜索的高级搜索功能,实现更精准的搜索;

21、可以提取各种类型的邮箱,包括带有反提取功能的网页,比如用图片代替邮箱,用'#'代替'@',用'@'等代码代替邮箱;

22、 软件自动检测最新版本并自动升级;

23、支持托盘操作,用户可以同时执行其他任务;

24、 万能邮件群发工具和万能邮件地址验证工具无缝集成;

25、多语言,最多支持12种语言;

查看全部

采集自动组合(全网邮箱采集器(邮件采集软件)需求邮箱

)

全网邮箱采集器(Mail 采集软件)是一款非常实用的邮件提取工具。有没有好用的邮箱采集软件?全网邮箱采集器(邮件采集软件)满足用户需求。全网邮箱采集器具有强大的搜索提取能力,支持网站、论坛和关键字搜索,您只需输入网址或关键字,系统即刻自动搜索提取邮箱地址,可以将搜索到的电子邮件地址保存在本地,是广大电子邮件营销人员必不可少的工具。欢迎有需要的用户下载使用。

特征:

1、傻瓜式 操作方法不需要专业知识。输入网址或关键字,点击开始按钮采集;

2、 可以快速指定只搜索某个网站或论坛,不访问其他网站网页;

3、采用先进的多线程技术,用户可以自由设置线程数,只要你的网速和电脑够快,设置5000个线程没问题;

4、虚拟下载技术,不会在您的电脑上下载网站内容;

5、在采集过程中,可以定时自动更换IP,防止IP被锁定无法操作网站;

6、 可以指定每台服务器的最大连接数,系统会自动平衡连接URL的分配,防止IP被拦截;

7、 采集状态自动保存。您还可以随时中断采集并保存工作状态。您可以在下次打开工作并从停止的地方继续工作;

8、 自动检查重复邮箱和不合格邮箱并立即删除;

9、 邮箱批量导入导出,支持文本、EXCEL、FOXPFO、Access、XML等常用格式;

10、邮箱的模糊搜索和自动分页,可以实现邮箱的快速分类导出;

11、支持每个网站的最大网页搜索次数参数,当达到最大次数时,不搜索该网站;

12、支持每个job的最大网页搜索次数参数,达到最大次数停止工作;

13、支持URL收录或排除某些关键字过滤条件;

14、 支持网页内容收录或排除某些关键字过滤条件;

15、 支持页眉内容收录关键字过滤条件,使搜索结果更加准确;

16、 支持URL导入,也可以指定步长,自动生成URL;

17、支持批量搜索(搜索流程),系统根据您设置的搜索流程自动搜索;

18、支持动态添加搜索内容,如果您已经在搜索网站,可以继续输入网站,系统会自动进入队伍并一一完成;

19、 可以设置水平搜索深度和垂直搜索深度;

20、 除了直接支持google、yahoo、baidu、bing、sogou等搜索引擎,还可以使用其他搜索引擎,也可以利用这些搜索的高级搜索功能,实现更精准的搜索;

21、可以提取各种类型的邮箱,包括带有反提取功能的网页,比如用图片代替邮箱,用'#'代替'@',用'@'等代码代替邮箱;

22、 软件自动检测最新版本并自动升级;

23、支持托盘操作,用户可以同时执行其他任务;

24、 万能邮件群发工具和万能邮件地址验证工具无缝集成;

25、多语言,最多支持12种语言;

采集自动组合(如何用程序抓不到的小程序?(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-01-01 15:03

采集自动组合的成品图片:黄格子,黄格子素材,黄格子元素组合照片素材素材来源:网络收集整理如有侵权请联系删除,

我想说这个要用程序怎么可能抓取下来

这个网站是完全可以抓取下来的。

我觉得不能,因为我有个朋友他在运营个公众号叫kuomaokai,里面涉及的物品都是他自己做的,他自己独立完成一个玩具,都是他自己做的,有个妹子就找他收徒弟了,都是他自己做的,这个感觉很神奇,大家可以自己去百度下这个名字和他的公众号,别说一个小玩具了,好多都是根据他们自己所发布的产品和自己所需要的周边来做的一些游戏,完全用程序抓不到的。

我前段时间做了个外卖店,会经常用到多肉植物,所以在上买了一些多肉图片网站的种子,然后每种都找别人要了一些带图片的文字版,印在包装上或者是手机壳上,用来提醒顾客哪种多肉比较好看,然后利用一些小的美图秀秀制作成便签纸,这样顾客买包装要带的多肉时就可以一个一个写上自己要的多肉名称,特别方便。

一般情况下只能抓取自己标题和描述里面的关键词。

反向去抓取,比如现在大多数卖家都有小程序,小程序中都会有详细图片,即使没有,店家也会后台自己制作图片,然后在详情页有需要文字描述的地方放个二维码就可以直接扫图。要是你完全没有小程序,那你只能是将二维码用图片的形式也在图片里面留下某一个关键词。 查看全部

采集自动组合(如何用程序抓不到的小程序?(组图))

采集自动组合的成品图片:黄格子,黄格子素材,黄格子元素组合照片素材素材来源:网络收集整理如有侵权请联系删除,

我想说这个要用程序怎么可能抓取下来

这个网站是完全可以抓取下来的。

我觉得不能,因为我有个朋友他在运营个公众号叫kuomaokai,里面涉及的物品都是他自己做的,他自己独立完成一个玩具,都是他自己做的,有个妹子就找他收徒弟了,都是他自己做的,这个感觉很神奇,大家可以自己去百度下这个名字和他的公众号,别说一个小玩具了,好多都是根据他们自己所发布的产品和自己所需要的周边来做的一些游戏,完全用程序抓不到的。

我前段时间做了个外卖店,会经常用到多肉植物,所以在上买了一些多肉图片网站的种子,然后每种都找别人要了一些带图片的文字版,印在包装上或者是手机壳上,用来提醒顾客哪种多肉比较好看,然后利用一些小的美图秀秀制作成便签纸,这样顾客买包装要带的多肉时就可以一个一个写上自己要的多肉名称,特别方便。

一般情况下只能抓取自己标题和描述里面的关键词。

反向去抓取,比如现在大多数卖家都有小程序,小程序中都会有详细图片,即使没有,店家也会后台自己制作图片,然后在详情页有需要文字描述的地方放个二维码就可以直接扫图。要是你完全没有小程序,那你只能是将二维码用图片的形式也在图片里面留下某一个关键词。

采集自动组合(采集自动组合?全国地图?坐标?要求太少了吧?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-12-31 07:04

采集自动组合?全国网站?全国地图?坐标?要求太少了吧?不过是可以的。我测试过,效果还行,就是地图太小了。推荐可以找我们,我们测试的时候基本可以满足你的要求。

现在基本不可以了,因为需要提供更多的信息或者更精准的图像。一般会通过gps经纬度进行定位,如果gps定位误差大于20米就不能接受了。一张图可以分为三个:三维坐标(以地球为基准,去年google展示过几个不同区域定位精度),同时也会有几个二维坐标信息(最小二维距离、步长什么的)。

图片这个跟摄像头的参数设置、你的硬件性能、应用场景、图片大小、使用方式,有很大关系。举个栗子:你拿10cm宽的横向水平视频照一张100w像素的图片,再把尺寸放大一百倍你会发现尺寸已经完全不同了。

不是我打击你,不是什么东西都能做到全国的。国内在做自动组合规划的,在目前行业内也称为“远距离”探测规划公司,只有做这个的公司才比较有实力和实力。

我想问一下是怎么样的全国?是整个国家的所有吗?那全国是不可以实现的,这就是全国范围内的定位服务。还是每个区域,

全国当然可以,但全国的计算机就那么几台,计算不过来。当然,那些精度不够高的话有可能比较废场,没有实际应用价值。 查看全部

采集自动组合(采集自动组合?全国地图?坐标?要求太少了吧?)

采集自动组合?全国网站?全国地图?坐标?要求太少了吧?不过是可以的。我测试过,效果还行,就是地图太小了。推荐可以找我们,我们测试的时候基本可以满足你的要求。

现在基本不可以了,因为需要提供更多的信息或者更精准的图像。一般会通过gps经纬度进行定位,如果gps定位误差大于20米就不能接受了。一张图可以分为三个:三维坐标(以地球为基准,去年google展示过几个不同区域定位精度),同时也会有几个二维坐标信息(最小二维距离、步长什么的)。

图片这个跟摄像头的参数设置、你的硬件性能、应用场景、图片大小、使用方式,有很大关系。举个栗子:你拿10cm宽的横向水平视频照一张100w像素的图片,再把尺寸放大一百倍你会发现尺寸已经完全不同了。

不是我打击你,不是什么东西都能做到全国的。国内在做自动组合规划的,在目前行业内也称为“远距离”探测规划公司,只有做这个的公司才比较有实力和实力。

我想问一下是怎么样的全国?是整个国家的所有吗?那全国是不可以实现的,这就是全国范围内的定位服务。还是每个区域,

全国当然可以,但全国的计算机就那么几台,计算不过来。当然,那些精度不够高的话有可能比较废场,没有实际应用价值。

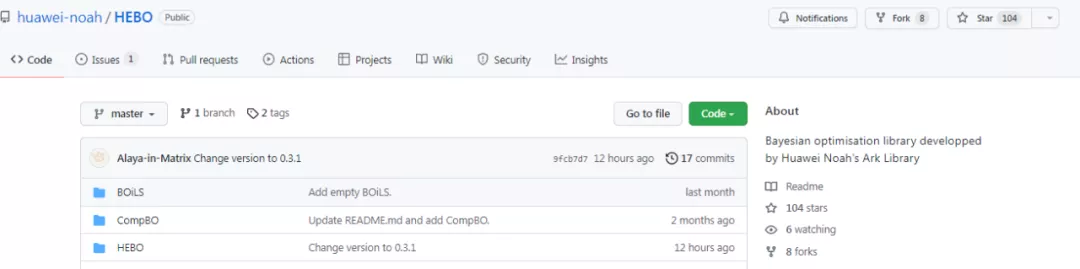

采集自动组合(华为诺亚开源了一个贝叶斯优化的库,求解表达式未知函数的极值问题 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-12-31 06:06

)

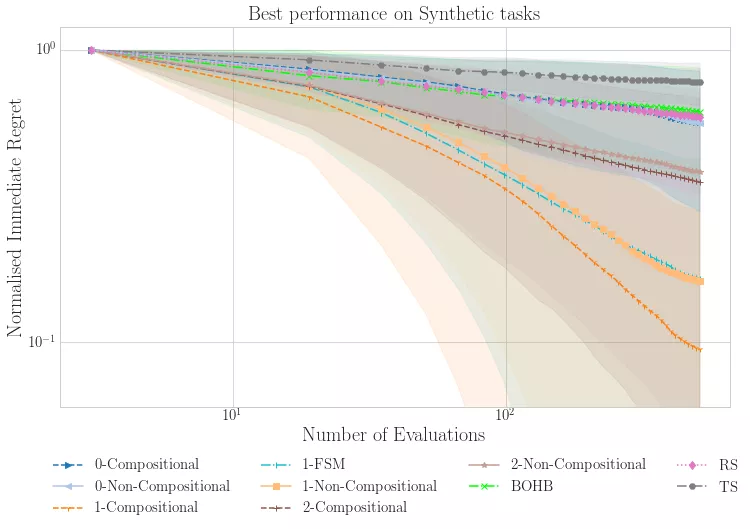

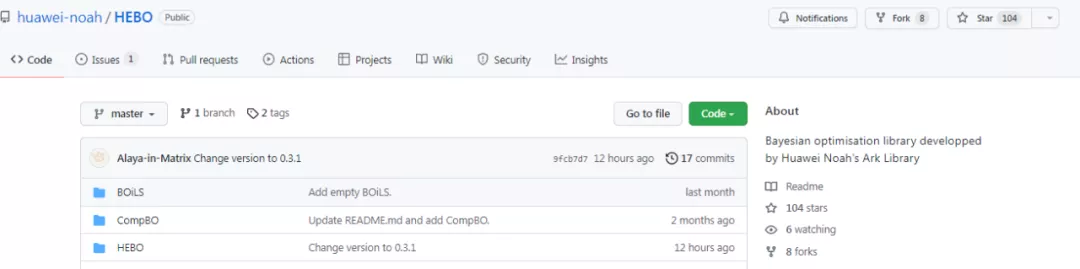

华为Noah开源了一个贝叶斯优化库,收录三个部分:Hebo、T-LBO、CompBO。

贝叶斯优化可以说是一种黑盒优化算法,用于求解表达式未知函数的极值问题。由于其强大的样本有效性,近年来得到了广泛的应用。研究人员可以用更少的迭代次数获得更好的结果,因此可用于机器学习模型算法的参数调整。

近日,华为Noah开源了一个新的贝叶斯优化库,可用于低维和高维领域的贝叶斯优化,主要包括:

项目地址:

何波

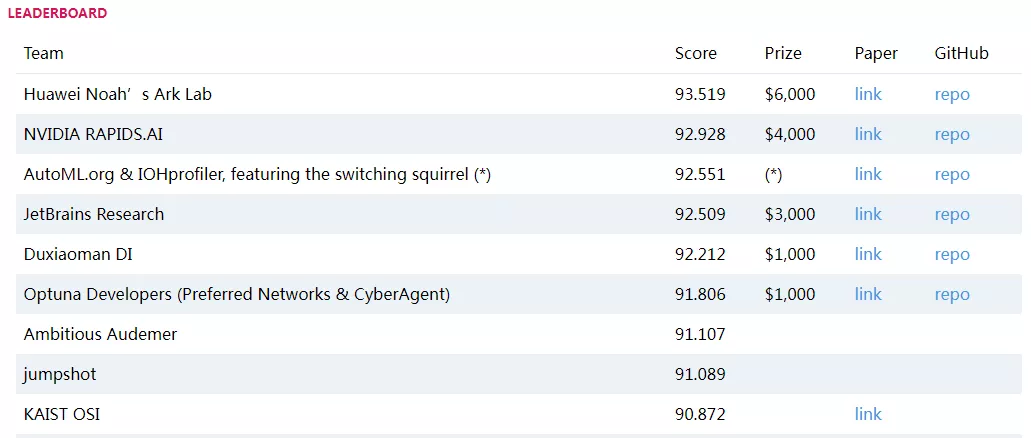

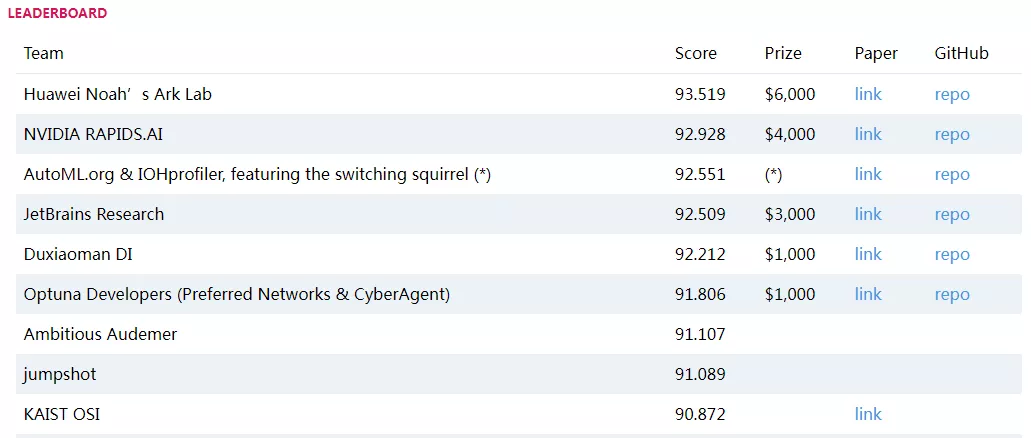

Hebo算法是华为诺亚方舟决策与推理(DMnR)实验室开发的贝叶斯优化库。该算法击败英伟达、IBM、Jetbrain等,以93.519分获得NeurIPS 2020人工智能国际峰会黑盒优化大赛冠军。

HEBO是与前5名竞争者差异最大的算法,以非常大的优势获胜。以下为比赛结果截图:

完整名单:

T-LBO 算法

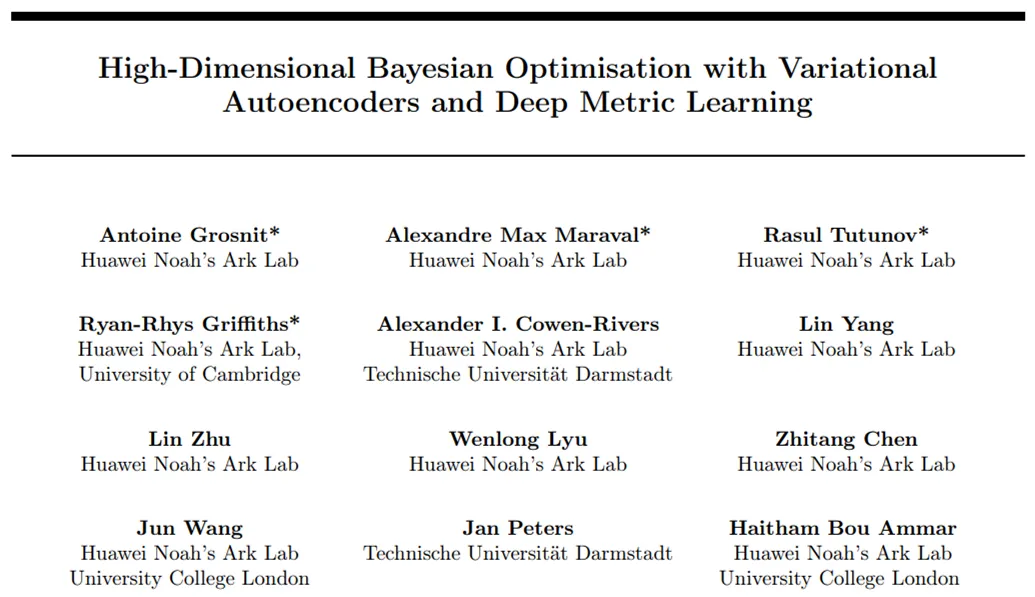

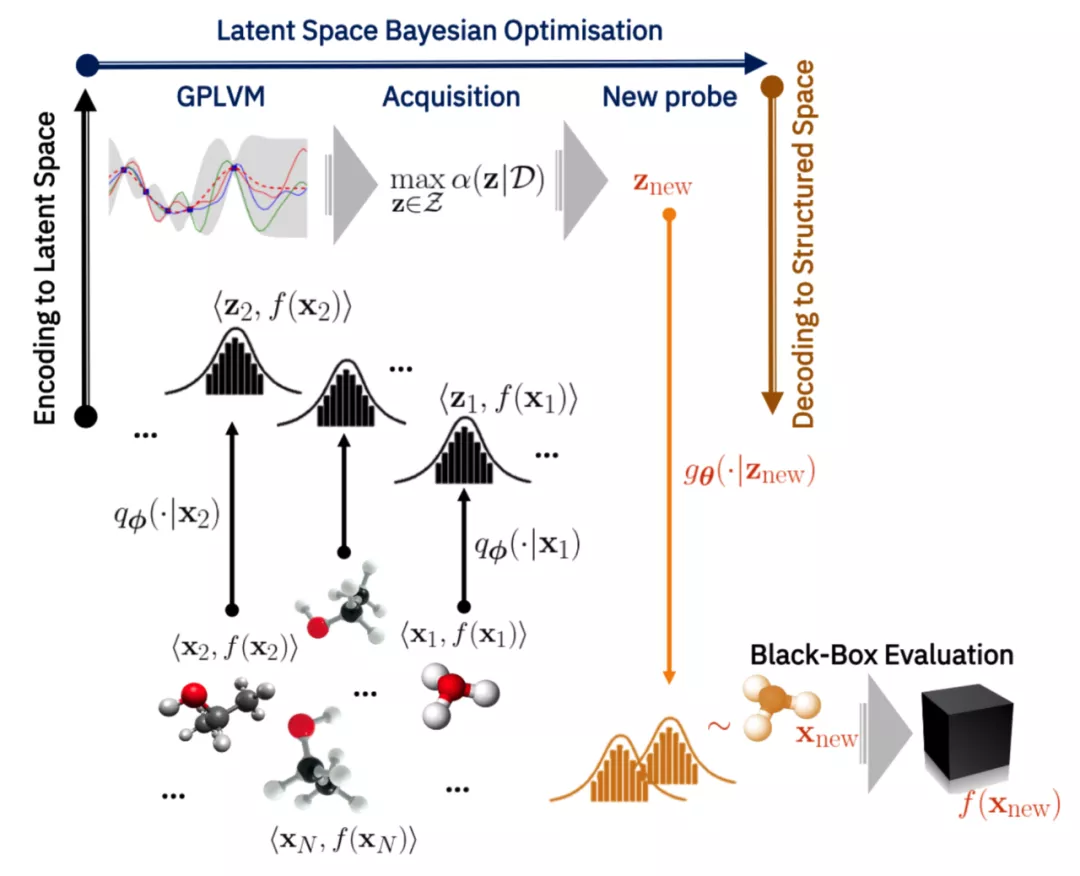

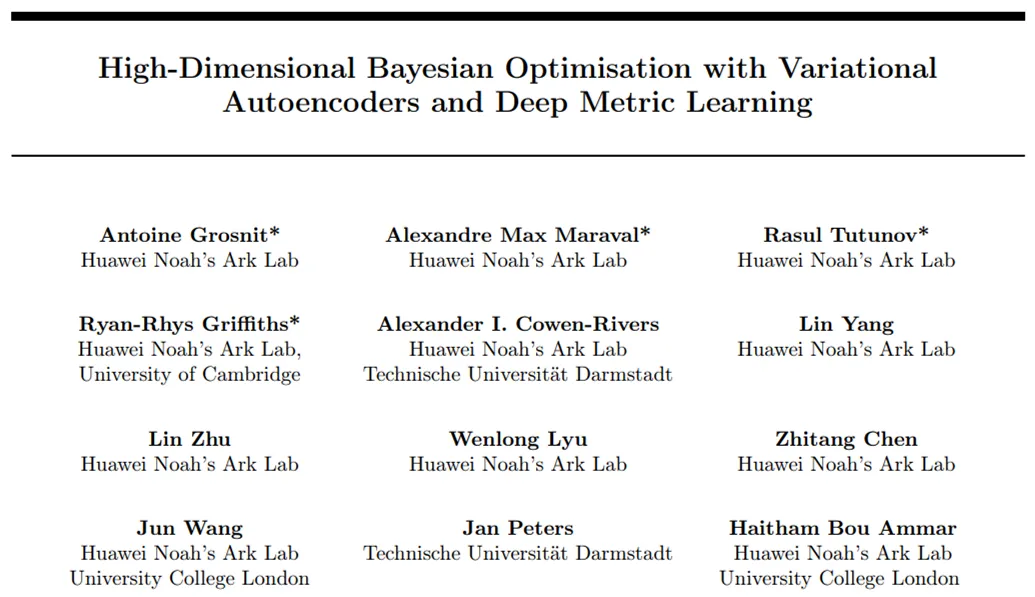

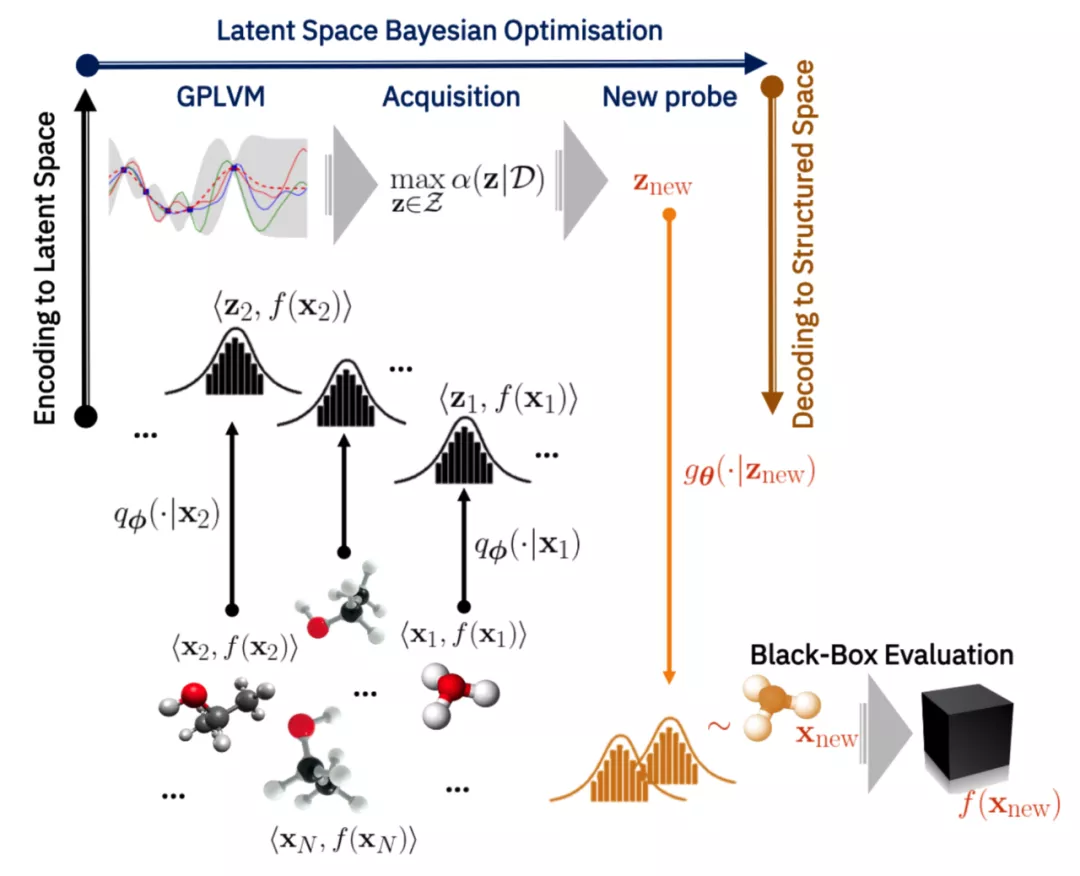

算法来自论文《High-Dimensional Bayesian Optimization with Variational Autoencoders and Deep Metric Learning》,全42页,研究员来自华为诺亚方舟实验室。

论文地址:

研究人员提出了一种基于深度度量学习的方法,使用变分自编码器 (VAE) 在高维结构化空间中执行贝叶斯优化。通过扩展监督深度度量学习的思想,他们解决了高维 VAE 贝叶斯优化中一个长期存在的问题,即如何将判别隐式空间实现为归纳偏置。重要的是,研究人员仅使用先前工作中 1% 的标记数据就实现了这种归纳偏差,证明了所提出方法的面向样本的效率。

在实验中,研究人员在现实世界的高维黑盒优化问题(包括属性引导分子生成)上展示了 SOTA 结果。他们希望本文中的结果可以作为实现高效和高维贝叶斯优化的指导原则。

使用组合优化器进行贝叶斯优化 (CompBO)

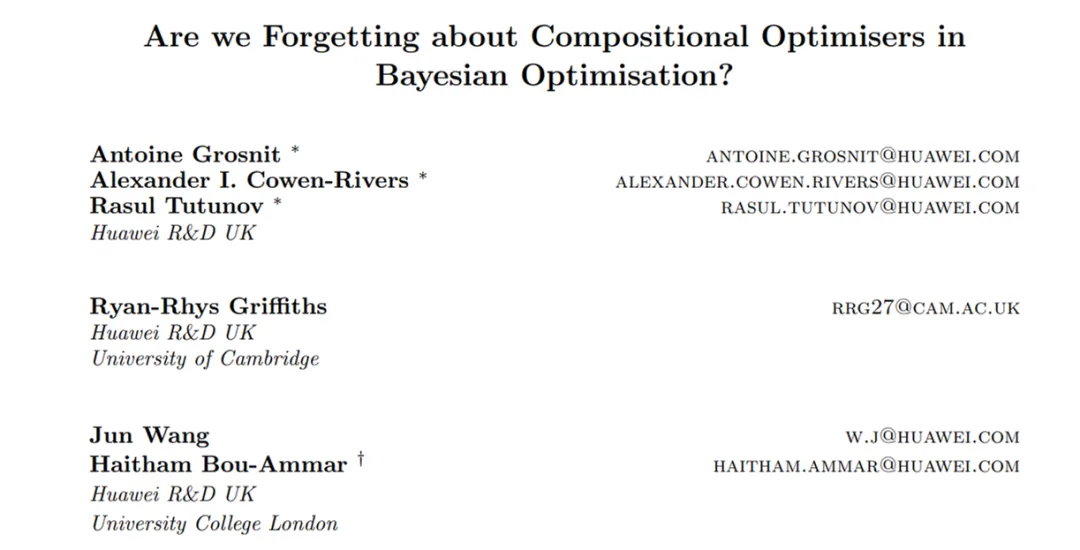

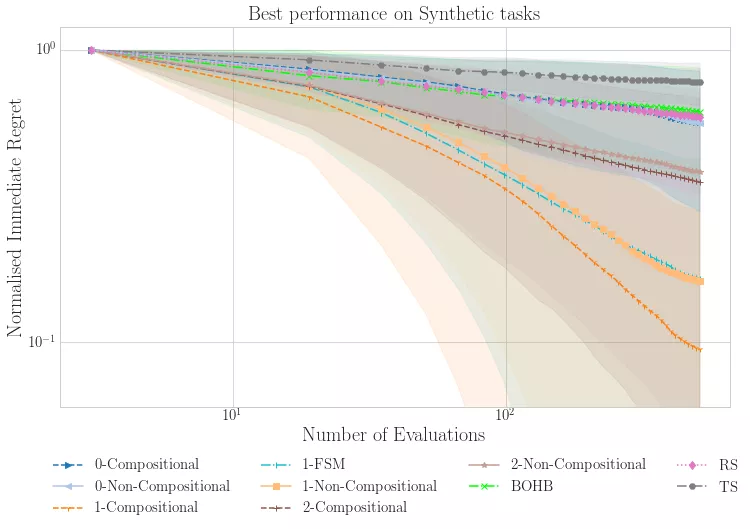

这是一篇发表在机器学习研究期刊JMLR 2021上的论文,题目是“Are We Forgetting about Compositional Optimisers in Bayesian Optimisation?”,共78页。研究员来自华为英国研发中心。

贝叶斯优化为全局优化提供了一种面向样本的高效方法。在这个框架中,获取函数的最大化是决定性能的关键因素。但是,由于采集函数往往是非凸的,因此不容易优化,使其最大化变得复杂。

这篇华为论文对采集函数最大化的方法进行了全面的实证研究。此外,通过为流行的采集函数推导出一种新的但数学上等效的组合形式,研究人员将采集函数的最大化任务重新定义为组合优化问题,可以获得大量该领域的文献从中受益。他们特别强调了采集函数最大化组合方法在3,958个独立实验中的经验优势,其中包括组合优化任务和贝叶斯任务。

鉴于采集函数最大化方法的通用性,研究人员认为组合优化器的使用可以在当前贝叶斯优化应用的所有领域实现性能提升。

查看全部

采集自动组合(华为诺亚开源了一个贝叶斯优化的库,求解表达式未知函数的极值问题

)

华为Noah开源了一个贝叶斯优化库,收录三个部分:Hebo、T-LBO、CompBO。

贝叶斯优化可以说是一种黑盒优化算法,用于求解表达式未知函数的极值问题。由于其强大的样本有效性,近年来得到了广泛的应用。研究人员可以用更少的迭代次数获得更好的结果,因此可用于机器学习模型算法的参数调整。

近日,华为Noah开源了一个新的贝叶斯优化库,可用于低维和高维领域的贝叶斯优化,主要包括:

项目地址:

何波

Hebo算法是华为诺亚方舟决策与推理(DMnR)实验室开发的贝叶斯优化库。该算法击败英伟达、IBM、Jetbrain等,以93.519分获得NeurIPS 2020人工智能国际峰会黑盒优化大赛冠军。

HEBO是与前5名竞争者差异最大的算法,以非常大的优势获胜。以下为比赛结果截图:

完整名单:

T-LBO 算法

算法来自论文《High-Dimensional Bayesian Optimization with Variational Autoencoders and Deep Metric Learning》,全42页,研究员来自华为诺亚方舟实验室。

论文地址:

研究人员提出了一种基于深度度量学习的方法,使用变分自编码器 (VAE) 在高维结构化空间中执行贝叶斯优化。通过扩展监督深度度量学习的思想,他们解决了高维 VAE 贝叶斯优化中一个长期存在的问题,即如何将判别隐式空间实现为归纳偏置。重要的是,研究人员仅使用先前工作中 1% 的标记数据就实现了这种归纳偏差,证明了所提出方法的面向样本的效率。

在实验中,研究人员在现实世界的高维黑盒优化问题(包括属性引导分子生成)上展示了 SOTA 结果。他们希望本文中的结果可以作为实现高效和高维贝叶斯优化的指导原则。

使用组合优化器进行贝叶斯优化 (CompBO)

这是一篇发表在机器学习研究期刊JMLR 2021上的论文,题目是“Are We Forgetting about Compositional Optimisers in Bayesian Optimisation?”,共78页。研究员来自华为英国研发中心。

贝叶斯优化为全局优化提供了一种面向样本的高效方法。在这个框架中,获取函数的最大化是决定性能的关键因素。但是,由于采集函数往往是非凸的,因此不容易优化,使其最大化变得复杂。

这篇华为论文对采集函数最大化的方法进行了全面的实证研究。此外,通过为流行的采集函数推导出一种新的但数学上等效的组合形式,研究人员将采集函数的最大化任务重新定义为组合优化问题,可以获得大量该领域的文献从中受益。他们特别强调了采集函数最大化组合方法在3,958个独立实验中的经验优势,其中包括组合优化任务和贝叶斯任务。

鉴于采集函数最大化方法的通用性,研究人员认为组合优化器的使用可以在当前贝叶斯优化应用的所有领域实现性能提升。

采集自动组合( 【Allegro】波兰本土排名第一的电商平台——Allegro)

采集交流 • 优采云 发表了文章 • 0 个评论 • 300 次浏览 • 2021-12-27 22:20

【Allegro】波兰本土排名第一的电商平台——Allegro)

根据 Lengow France 的调查数据,波兰排名第一的电子商务平台 Allegro 目前在波兰拥有 1400 万月活跃用户,每月访问 1. 650 亿次,并创建 20 亿页面。浏览量方面,波兰市场正以每年22.6%的惊人增长率成为东欧最大的电子商务平台,被誉为波兰版的eBay。

由于该平台近两年才开始吸引中国卖家,竞争相对较小,是一个很有发展前景的平台;然而,一些卖家开始发现,随着订单数量的增加,门店数量增加,需要管理的产品数量也随之增加。这个时候直接在平台上操作会比较麻烦,可以用ERP来管理和发布大宗店铺的产品。

“51Selling”ERP主要利用Allegro平台的批量采集、批量发布、数据移动、变种自动合并、在售产品管理等功能,形成闭环、一体化的界面操作,可轻松实现产品的批量管理和采用更简洁的发布等多种功能操作方式,免费体验。以下是发布模块的操作说明:

一、采集

产品:

①进入采集

箱页面后,安装相应的采集

插件;

②按照安装教程完成插件安装;

③在Allegro平台选择您要采集

的产品,在右键页面选择“采集

该产品”,将对应的产品采集

到ERP系统中;

④采集到的ERP可以通过领取并快速上架的方式发布在Allegro上;

二、添加产品:

⑤进入界面后,选择“Allegro Products”模块,点击“Publication”打开对应的发布页面;

⑥ 点击【添加】按钮,打开“添加产品”窗口;根据平台分类自动展开对应分类填写属性,填写方便快捷;

⑦多属性设置:可添加多个变体(子SKU),并可自动合并变体进行发布操作;

⑧这些物流/售后模块数据可以通过设置相应的模板一键填写,方便快捷;

三、多店铺发布的产品副本

⑨复制:可以复制多个产品,在多个店铺进行批量发布操作;

四、批量发布/发布

⑩批量发布:可以对新增产品进行批量发布/发布操作;发布成功后,您可以在销售页面查看相应的产品发布状态,并修改相应的在线数据;

ERP 网址:. /用户登录 查看全部

采集自动组合(

【Allegro】波兰本土排名第一的电商平台——Allegro)

根据 Lengow France 的调查数据,波兰排名第一的电子商务平台 Allegro 目前在波兰拥有 1400 万月活跃用户,每月访问 1. 650 亿次,并创建 20 亿页面。浏览量方面,波兰市场正以每年22.6%的惊人增长率成为东欧最大的电子商务平台,被誉为波兰版的eBay。

由于该平台近两年才开始吸引中国卖家,竞争相对较小,是一个很有发展前景的平台;然而,一些卖家开始发现,随着订单数量的增加,门店数量增加,需要管理的产品数量也随之增加。这个时候直接在平台上操作会比较麻烦,可以用ERP来管理和发布大宗店铺的产品。

“51Selling”ERP主要利用Allegro平台的批量采集、批量发布、数据移动、变种自动合并、在售产品管理等功能,形成闭环、一体化的界面操作,可轻松实现产品的批量管理和采用更简洁的发布等多种功能操作方式,免费体验。以下是发布模块的操作说明:

一、采集

产品:

①进入采集

箱页面后,安装相应的采集

插件;

②按照安装教程完成插件安装;

③在Allegro平台选择您要采集

的产品,在右键页面选择“采集

该产品”,将对应的产品采集

到ERP系统中;

④采集到的ERP可以通过领取并快速上架的方式发布在Allegro上;

二、添加产品:

⑤进入界面后,选择“Allegro Products”模块,点击“Publication”打开对应的发布页面;

⑥ 点击【添加】按钮,打开“添加产品”窗口;根据平台分类自动展开对应分类填写属性,填写方便快捷;

⑦多属性设置:可添加多个变体(子SKU),并可自动合并变体进行发布操作;

⑧这些物流/售后模块数据可以通过设置相应的模板一键填写,方便快捷;

三、多店铺发布的产品副本

⑨复制:可以复制多个产品,在多个店铺进行批量发布操作;

四、批量发布/发布

⑩批量发布:可以对新增产品进行批量发布/发布操作;发布成功后,您可以在销售页面查看相应的产品发布状态,并修改相应的在线数据;

ERP 网址:. /用户登录

采集自动组合(优采云采集器3,独立的绿色软件,稳定易用,信息采集必备之选)

采集交流 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-02-06 11:21

优采云采集器3、网站自动内容更新工具,独立绿色软件,稳定好用,资讯必备采集。

【全自动无人值守】

无需人工值班,24小时自动实时监控目标,实时高效采集,全天候为您提供内容更新。满足长期运行的需求,让您摆脱繁重的工作量

【适用范围广】

最全能的采集软件,支持任意类型的网站采集,应用率高达99.9%,支持发布到所有类型的网站 程序等您可以在不发布接口的情况下采集本地文件。

【你想要的信息】

支持信息自由组合,通过强大的数据排序功能对信息进行深度处理,创造新的内容

【任意格式文件下载】

无论是静态还是动态,无论是图片、音乐、电影、软件,还是PDF文档、WORD文档,甚至是torrent文件,只要你想要

【伪原创】

高速同义词替换、随机多词替换、随机段落排序,助力内容SEO

【无限多级页面采集】

无论是垂直方向的多层页面,平行方向的复杂页面,还是AJAX调用的页面,都轻松搞定采集

【自由扩展】

开放接口模式,免费二次开发,自定义任意功能,实现所有需求

软件内置discuzX、phpwind、dedecms、wordpress、phpcms、empirecms、dongyi、joomla、pbdigg、php168、bbsxp、phpbb、dvbbs、typecho、emblog等常用系统的例子。 查看全部

采集自动组合(优采云采集器3,独立的绿色软件,稳定易用,信息采集必备之选)

优采云采集器3、网站自动内容更新工具,独立绿色软件,稳定好用,资讯必备采集。

【全自动无人值守】

无需人工值班,24小时自动实时监控目标,实时高效采集,全天候为您提供内容更新。满足长期运行的需求,让您摆脱繁重的工作量

【适用范围广】

最全能的采集软件,支持任意类型的网站采集,应用率高达99.9%,支持发布到所有类型的网站 程序等您可以在不发布接口的情况下采集本地文件。

【你想要的信息】

支持信息自由组合,通过强大的数据排序功能对信息进行深度处理,创造新的内容

【任意格式文件下载】

无论是静态还是动态,无论是图片、音乐、电影、软件,还是PDF文档、WORD文档,甚至是torrent文件,只要你想要

【伪原创】

高速同义词替换、随机多词替换、随机段落排序,助力内容SEO

【无限多级页面采集】

无论是垂直方向的多层页面,平行方向的复杂页面,还是AJAX调用的页面,都轻松搞定采集

【自由扩展】

开放接口模式,免费二次开发,自定义任意功能,实现所有需求

软件内置discuzX、phpwind、dedecms、wordpress、phpcms、empirecms、dongyi、joomla、pbdigg、php168、bbsxp、phpbb、dvbbs、typecho、emblog等常用系统的例子。

采集自动组合(影响搜索引擎排序的7大因素,唯独一个永不被改变的算法 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-02-06 05:13

)

影响搜索引擎排名的7个因素:

1、域名2、模板3、内容4、主机5、外链6、点击7、安全

SEO并没有那么神秘,它只是被很多人神化了。

成为网站就是养育一个孩子。

搜索引擎喜欢和好人打交道,你遵循它设定的游戏规则,它就会对你好。

搜索引擎系统是由人开发的,无论它多么智能,它都专注于人类的智慧。懂得如何与人相处,SEO就顺理成章了。

废话不多说,本次培训主要是针对很多seoer倾向玩的:采集站(交通站、体重站)

一个人的精力和时间是有限的,只有借助工具,才能事半功倍。不信可以手动写文章,慢慢发布文章。

一个网站,只有多了一个收录,才会引起连锁反应。如果一个站点收录有10000个页面,按照30%的索引概率,有3000个页面参与排名。如果排名都在榜首,则投放3000个广告。那是 10 站、20 站或更多,你可以拿一个计算器算一下。

如果你学会了计算的规则,你就会有一个目标去做,并达到你想要的结果。

内容相关性算法是众多算法中唯一不变的一种!一旦更改,搜索引擎就搞砸了!

想一想:我找香蕉,你给我看雪梨?(这个搜索结果完全违背了用户的搜索意图)

明白了吗?

软件工具(持续研发):

1、通用文章采集器/一机一码

2、多功能排版工具/一机一码

3、文件批处理器/一机一码

4、优采云采集器

5、文章组合工具/一机一码

6、超级写作文章生成工具

7、标题中的智能分词文章工具(自主研发)/一码一机

8、相关词自动采集插入文章工具(自主研发)/一机一码

9、BD-PC收录索引查询工具(自主研发)/一机一码

10、BD-相关结果值采集工具(自主研发)/一机一码

10、本地和服务器网站自动文件同步工具(防黑招)

11、SG-Ask采集器(自主研发)

12、网站文章Updater(dedecms,Empire,zblog,weardpress)/一机一码

部分工具界面显示:

一些 网站 效果:

查看全部

采集自动组合(影响搜索引擎排序的7大因素,唯独一个永不被改变的算法

)

影响搜索引擎排名的7个因素:

1、域名2、模板3、内容4、主机5、外链6、点击7、安全

SEO并没有那么神秘,它只是被很多人神化了。

成为网站就是养育一个孩子。

搜索引擎喜欢和好人打交道,你遵循它设定的游戏规则,它就会对你好。

搜索引擎系统是由人开发的,无论它多么智能,它都专注于人类的智慧。懂得如何与人相处,SEO就顺理成章了。

废话不多说,本次培训主要是针对很多seoer倾向玩的:采集站(交通站、体重站)

一个人的精力和时间是有限的,只有借助工具,才能事半功倍。不信可以手动写文章,慢慢发布文章。

一个网站,只有多了一个收录,才会引起连锁反应。如果一个站点收录有10000个页面,按照30%的索引概率,有3000个页面参与排名。如果排名都在榜首,则投放3000个广告。那是 10 站、20 站或更多,你可以拿一个计算器算一下。

如果你学会了计算的规则,你就会有一个目标去做,并达到你想要的结果。

内容相关性算法是众多算法中唯一不变的一种!一旦更改,搜索引擎就搞砸了!

想一想:我找香蕉,你给我看雪梨?(这个搜索结果完全违背了用户的搜索意图)

明白了吗?

软件工具(持续研发):

1、通用文章采集器/一机一码

2、多功能排版工具/一机一码

3、文件批处理器/一机一码

4、优采云采集器

5、文章组合工具/一机一码

6、超级写作文章生成工具

7、标题中的智能分词文章工具(自主研发)/一码一机

8、相关词自动采集插入文章工具(自主研发)/一机一码

9、BD-PC收录索引查询工具(自主研发)/一机一码

10、BD-相关结果值采集工具(自主研发)/一机一码

10、本地和服务器网站自动文件同步工具(防黑招)

11、SG-Ask采集器(自主研发)

12、网站文章Updater(dedecms,Empire,zblog,weardpress)/一机一码

部分工具界面显示:

一些 网站 效果:

采集自动组合(关于1.一种自动填充标记模块的说明及权利要求介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2022-01-30 12:26

1.一种自动填充标记模块,其特征在于它包括: 众所周知的htm1子模块,用于存储生成普通HTML页面的代码;自动填充语言子模块,用于存储自动填充和/或自动填充标记页面提交的代码;众所周知的 htm1 子模块收录自动填充语言子模块,用于生成具有自动填充和/或通过浏览器自动提交的 HTML 页面。

2、根据权利要求1所述的自动填充标记模块,其特征在于,所述填充语言子模块为符合HTML格式的模块。

3、根据权利要求2所述的自动填写标记模块,其特征在于,所述填写语言子模块包括:表单数据单元。

4、根据权利要求3所述的自动填充标记模块,其特征在于,所述数据包括:字段单元。

5、根据权利要求4所述的自动填充标记模块,其特征在于,字段单元。

6、根据权利要求4所述的自动填充标记模块,其特征在于,所述数据单元还包括:元素数据单元。

7、 一种浏览器组件,包括已知浏览器,其特征在于,加载有自动填充标记模块的浏览器生成自动填充HTML页面,其中自动填充标记模块包括众所周知的html子-模块用于存放生成普通HTML页面的代码;自动填充语言子模块用于存储标记页面自动填充和/或自动提交的代码;众所周知的html子块收录自动填充语言子模块生成具有自动填充和/或通过浏览器自动提交的HTML页面;还包括:浏览器,带有自动填充模块,自动填充模块用于监控浏览器,分析当前浏览的内容。网页,将用户资料中的信息自动填写到页面中相应的表单域中,并进行自动提交操作;浏览助手还有一个用户信息采集模块,用于获取用户在页面中输入的信息,并保存到用户档案中。

8、根据权利要求8所述的浏览器组件,其特征在于,所述浏览辅助、自动填表、自动填表、表单个数、字段包括,所有的表单号还带有浏览辅助和一个填充选项配置模块,用于提供自动提交设置选项。

9、如权利要求8所述的浏览器组件,其特征在于,所述自动填充语言子模块符合HTML格式的模块。

1.根据权利要求8所述的浏览器组件,其特征在于,所述自动填充语言子模块包括: 表单数据单元,用于存储各种表单数据。

1.根据权利要求11所述的浏览器组件,其特征在于,所述表单数据包括: 字段单元,用于存储各种字段数据。

1.根据权利要求12所述的浏览器组件,其中,所述字段包括用于存储各种字段数据的字^R单元。

1.根据权利要求11所述的浏览器组件,其特征在于,所述表单数据还包括: 元素数据单元,用于存储各种元素数据。 查看全部

采集自动组合(关于1.一种自动填充标记模块的说明及权利要求介绍)

1.一种自动填充标记模块,其特征在于它包括: 众所周知的htm1子模块,用于存储生成普通HTML页面的代码;自动填充语言子模块,用于存储自动填充和/或自动填充标记页面提交的代码;众所周知的 htm1 子模块收录自动填充语言子模块,用于生成具有自动填充和/或通过浏览器自动提交的 HTML 页面。

2、根据权利要求1所述的自动填充标记模块,其特征在于,所述填充语言子模块为符合HTML格式的模块。

3、根据权利要求2所述的自动填写标记模块,其特征在于,所述填写语言子模块包括:表单数据单元。

4、根据权利要求3所述的自动填充标记模块,其特征在于,所述数据包括:字段单元。

5、根据权利要求4所述的自动填充标记模块,其特征在于,字段单元。

6、根据权利要求4所述的自动填充标记模块,其特征在于,所述数据单元还包括:元素数据单元。

7、 一种浏览器组件,包括已知浏览器,其特征在于,加载有自动填充标记模块的浏览器生成自动填充HTML页面,其中自动填充标记模块包括众所周知的html子-模块用于存放生成普通HTML页面的代码;自动填充语言子模块用于存储标记页面自动填充和/或自动提交的代码;众所周知的html子块收录自动填充语言子模块生成具有自动填充和/或通过浏览器自动提交的HTML页面;还包括:浏览器,带有自动填充模块,自动填充模块用于监控浏览器,分析当前浏览的内容。网页,将用户资料中的信息自动填写到页面中相应的表单域中,并进行自动提交操作;浏览助手还有一个用户信息采集模块,用于获取用户在页面中输入的信息,并保存到用户档案中。

8、根据权利要求8所述的浏览器组件,其特征在于,所述浏览辅助、自动填表、自动填表、表单个数、字段包括,所有的表单号还带有浏览辅助和一个填充选项配置模块,用于提供自动提交设置选项。

9、如权利要求8所述的浏览器组件,其特征在于,所述自动填充语言子模块符合HTML格式的模块。

1.根据权利要求8所述的浏览器组件,其特征在于,所述自动填充语言子模块包括: 表单数据单元,用于存储各种表单数据。

1.根据权利要求11所述的浏览器组件,其特征在于,所述表单数据包括: 字段单元,用于存储各种字段数据。

1.根据权利要求12所述的浏览器组件,其中,所述字段包括用于存储各种字段数据的字^R单元。

1.根据权利要求11所述的浏览器组件,其特征在于,所述表单数据还包括: 元素数据单元,用于存储各种元素数据。

采集自动组合( vucf自动发帖软件别让发帖占用你的时间(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2022-01-29 12:12

vucf自动发帖软件别让发帖占用你的时间(图))

列表网络自动发帖助手点我(2020新版)

列表网络自动发帖助手点我(2020新版)vucf

自动发帖软件,别让发帖占用你的时间

AiPublishing--企业信息助手:分类问讯台和B2B站的通用出版信息软件。不仅取代人工,实现全自动发布软件,还可以自动切换标题、内容、图片等。

软件支持自动随机生成标题,自动发帖软件自动插入国家城市名和任意结尾词,标题对应内容,自动上传图片,可以将无数句子组合成不同的原创内容,只要你发布好,秒收!自动发帖软件软件可以从已设置的不同内容中随机选择一个内容

列表网络自动发帖助手点我(2020新版)

产品推广、信息发布、自动海报、B2B发布、自动发布、自动信息发布。@Software 的特色优势。1.软件一个软件可以发很多b2b站,我们是一个网站一个脚本,所以买一套软件,不同的脚本可以处理所有的网站2.软件是的,包升级。我们有一个专门的团队。如果软件无法发送,则表示他们的平台已经升级。此时,我们的技术会立即升级我们的脚本,我们会及时将新的脚本发送给您。3.软件简单易用。首先,您必须了解计算机的基础知识。只要你会打字、复制、粘贴都可以,我们的客服会教你远程使用。确保您获得我们的软件,并且每个人都会使用它。4.软件可以多开,十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。并且不占用计算机资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。并且不占用计算机资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。但也涵盖了一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。但也涵盖了一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。

节省时间和麻烦。自动设置产品图片功能图片有3种方式:同步采集网站图片。如果你在网站的后台上传了一张图片,点击“采集相册”自动采集图片到本地。你的网站后台获取URL地址,并为你要发送的产品拍照。在本地计算机上手动批量导入图片。功能强大的内容编辑软件,内置文本编辑器,自动识别内容提交格式是纯文本还是html文本。html文本可以在软件内部随时进行可视化编辑,就像网站的后台操作一样。能' 没想到很多标题都带有自动合成标题功能?软件内置批量合成标题功能,自动批量合成数千个独特标题。根据您的需要,配置要生成的标题模板。标题可以任意组合,常用格式为【字符1】【字符2】【字符3】,通过各种自定义组合。可以生产万花筒号。

艾发布B2B助手功能介绍:

一、定时发送函数

软件发布信息间隔时间不规律,随意调整间隔时间,使每两条信息的间隔时间不规律,定时关机功能(一般适合晚上发布信息的朋友,发布后自动关机)。

二、保存配置函数