采集自动组合

采集拼多多评价中的晒图链接并下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 330 次浏览 • 2022-05-21 06:25

访问电商记网站()安装浏览器插件v9.1.4以上版本即可使用本功能。

流程一开始,用户输入一个拼多多商品ID。流程会打开一个拼多多商品评价页面,点击“图/视频”选项。

然后自动往下滚动页面。

在评价页面滚动过程中,浏览器从网站获得评价数据,这些数据被解析为表格。当流程结束运行后,自动保存为Excel文件。

采集结果包含5列或更多,第一列是评价内容,第二列是SKU名称,第三列是SKU的值,第四列是日期,第五列或更多是图片。

在采集评价过程中,下载所有图片链接,如图示底部。

查看全部

采集拼多多评价中的晒图链接并下载

访问电商记网站()安装浏览器插件v9.1.4以上版本即可使用本功能。

流程一开始,用户输入一个拼多多商品ID。流程会打开一个拼多多商品评价页面,点击“图/视频”选项。

然后自动往下滚动页面。

在评价页面滚动过程中,浏览器从网站获得评价数据,这些数据被解析为表格。当流程结束运行后,自动保存为Excel文件。

采集结果包含5列或更多,第一列是评价内容,第二列是SKU名称,第三列是SKU的值,第四列是日期,第五列或更多是图片。

在采集评价过程中,下载所有图片链接,如图示底部。

采集自动组合|“开放背后的密码”:miguelgiulia创业型的应用hadoop应用合集

采集交流 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-05-08 18:01

采集自动组合|“开放背后的密码”:miguelgiulia创业型的应用hadoop应用合集在往期的内容中,我们分享了linux命令、命令行与shell语言以及阿里云lamp系列学习,对于linux命令的学习有着较高的要求。同时,还会在后续分享linux系统编程、应用编程及python,此外还会分享各大云公司在开源云平台上所积累的最新成果,助力每个云用户成为最懂云的网络管理专家。

今天,我们继续分享最新的python及linux系统编程类内容。有个捷径,学会python基础语法以后,将其应用到linux系统编程的层面,再熟练使用实际的编程环境,很快就能学会并掌握一个新的应用开发语言。那就是python。python开发用于web的爬虫爬虫入门快,有深度,好就业。一个入门以后可以迅速在网站上生成一个爬虫,与百度等的爬虫一样,用户可以把自己在网站上获取的数据,制作成简单的自定义爬虫,然后大胆的放出来。

用户反馈数据真实、方便、效率高,商业价值大。抓取百度一级内容:一级页数:tweet(sina),qq(sina),有道(yahoo),推特(twitter)百度二级:时间:11:42:05,php(大约6秒),python(2分钟),java(1分钟),ruby(大约20秒)、豆瓣网(大约70秒)三级网站在php之外,加上twitter的返回页面,算是二级网站(php和java的共同)。

python和java的成本比较低,入门的时候确实是一个很好的选择。企业的网站,存在同一个内容分布,需要一级和二级,采集次数比较多的话,就会涉及到多个网站,可以实现。爬虫和java开发的数据比较像,因此这两者很容易重合。开发二级网站:一个页面:reddit(国外最大的)的返回页面:url中的serverurl请求地址,hostnamecachekeyuserfile.jpg目标网站:登录:域名/,你甚至可以自己写一个,爬取登录接口。

并且每个页面上都会有token,不能让爬虫登录页面时,跳过不应该爬取的token。再hostnamespace值是php路径(../,该页面的token返回给你,比如/seo,/index.php等,该页面的token就是/seo../。一个页面上有多个网站可能并不是问题,每个页面带多个token的情况下,通过reddit自己,再通过三级转发的方式就能到每个页面。

在爬取一个二级网站前,需要找到该页面所有的token对应的对应的,在python或java中都有实现方法。爬取百度一级页面:访问cookie,我们采用cookie来记录:一个cookie:访问百度timestamp:创建一个cookie的时间戳flush_cookie:将cookie刷新到指定的浏览器send_http请求:创建发送网络请求对。 查看全部

采集自动组合|“开放背后的密码”:miguelgiulia创业型的应用hadoop应用合集

采集自动组合|“开放背后的密码”:miguelgiulia创业型的应用hadoop应用合集在往期的内容中,我们分享了linux命令、命令行与shell语言以及阿里云lamp系列学习,对于linux命令的学习有着较高的要求。同时,还会在后续分享linux系统编程、应用编程及python,此外还会分享各大云公司在开源云平台上所积累的最新成果,助力每个云用户成为最懂云的网络管理专家。

今天,我们继续分享最新的python及linux系统编程类内容。有个捷径,学会python基础语法以后,将其应用到linux系统编程的层面,再熟练使用实际的编程环境,很快就能学会并掌握一个新的应用开发语言。那就是python。python开发用于web的爬虫爬虫入门快,有深度,好就业。一个入门以后可以迅速在网站上生成一个爬虫,与百度等的爬虫一样,用户可以把自己在网站上获取的数据,制作成简单的自定义爬虫,然后大胆的放出来。

用户反馈数据真实、方便、效率高,商业价值大。抓取百度一级内容:一级页数:tweet(sina),qq(sina),有道(yahoo),推特(twitter)百度二级:时间:11:42:05,php(大约6秒),python(2分钟),java(1分钟),ruby(大约20秒)、豆瓣网(大约70秒)三级网站在php之外,加上twitter的返回页面,算是二级网站(php和java的共同)。

python和java的成本比较低,入门的时候确实是一个很好的选择。企业的网站,存在同一个内容分布,需要一级和二级,采集次数比较多的话,就会涉及到多个网站,可以实现。爬虫和java开发的数据比较像,因此这两者很容易重合。开发二级网站:一个页面:reddit(国外最大的)的返回页面:url中的serverurl请求地址,hostnamecachekeyuserfile.jpg目标网站:登录:域名/,你甚至可以自己写一个,爬取登录接口。

并且每个页面上都会有token,不能让爬虫登录页面时,跳过不应该爬取的token。再hostnamespace值是php路径(../,该页面的token返回给你,比如/seo,/index.php等,该页面的token就是/seo../。一个页面上有多个网站可能并不是问题,每个页面带多个token的情况下,通过reddit自己,再通过三级转发的方式就能到每个页面。

在爬取一个二级网站前,需要找到该页面所有的token对应的对应的,在python或java中都有实现方法。爬取百度一级页面:访问cookie,我们采用cookie来记录:一个cookie:访问百度timestamp:创建一个cookie的时间戳flush_cookie:将cookie刷新到指定的浏览器send_http请求:创建发送网络请求对。

采集自动组合、保持两个信号间的通用法则

采集交流 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2022-05-05 23:01

采集自动组合、保持两个信号间的一致性,这是贯穿训练中心的通用法则。一直都想要开发这样一个app,但开发和运营并不是一个易事,最好的答案依然还是要在人工智能领域。在开发或者搭建前,我们应该要好好思考下这件事情和人工智能有什么关系。第一种解释可能会比较简单,那就是通过简单的接口来收集信息。再进一步展开解释,就是对用户授权给计算机所要求的收集样本特征的一套接口的封装,使得机器能够进行智能识别的过程。

如同电影《机械姬》里的电脑,能够通过直接改变物理世界中球球的运动轨迹来通知人的行动和动作,从而达到更好的运动控制的效果。但这毕竟太直接了,在我们开发app时,它已经根据获取的样本特征进行了二次处理,将它们固定下来,不能指导开发者,也不能提供任何数据给到app内使用。在这种情况下,我们必须要做的,是掌握应用的语义模型。

如同电影《机械姬》一样,或者像上文描述的世界,人与机器之间的关系并不是简单的“通过和拒绝”的逻辑关系,而是一种直接的依赖关系。语义模型能够让计算机掌握了人类知识中所有的逻辑规则、确定性特征,并让它们统一调整它们的运动结果,从而能够形成一套连贯和一致的效果。举个例子,人类在说话时,从头到尾,必须要呈现时间和空间两个方向上的关系,并且这两个方向必须有可靠的关联,才能表达清楚一段话的意思。

那么语义模型需要做的,就是确定说话方向和长度关系,确定关联关系,对两者进行编码,并输出逻辑关系和关联关系,确定语义规则,即说话顺序规则。在实际项目开发中,也是这样,基本都是反复从上到下,从左到右去进行语义模型的确定。它要做的,是从需求获取内容输入,在进行语义模型关联,形成语义规则,并将所有逻辑关系都运用在使用app上。

这里就涉及到有关语义模型的开发和使用了。选择一套合适的开发语言是首先要做的事情,确定何种语言开发的app比较适合人工智能,然后再选择开发语言的另一个重要标准,就是能否充分利用机器学习的技术。之前接触过的产品中,除了几家引入了机器学习,还有几家是接入了现有的语义模型,而且结果很成功。但语义模型相对计算机最基础和最重要的算法就差得远了,很多时候机器学习是提高app品质的基础,你只是用机器学习去做了重复的事情,自然不能保证方方面面。

两个方面,数据采集和自动组合。数据采集的流程基本是各家app都会有的,或者需要单独去做的,简单讲,大致是用户量大,数据收集量大的app,才需要做这些工作。整理好的信息用户只需要付出一定的paid成本,比如登录、注册,这样。 查看全部

采集自动组合、保持两个信号间的通用法则

采集自动组合、保持两个信号间的一致性,这是贯穿训练中心的通用法则。一直都想要开发这样一个app,但开发和运营并不是一个易事,最好的答案依然还是要在人工智能领域。在开发或者搭建前,我们应该要好好思考下这件事情和人工智能有什么关系。第一种解释可能会比较简单,那就是通过简单的接口来收集信息。再进一步展开解释,就是对用户授权给计算机所要求的收集样本特征的一套接口的封装,使得机器能够进行智能识别的过程。

如同电影《机械姬》里的电脑,能够通过直接改变物理世界中球球的运动轨迹来通知人的行动和动作,从而达到更好的运动控制的效果。但这毕竟太直接了,在我们开发app时,它已经根据获取的样本特征进行了二次处理,将它们固定下来,不能指导开发者,也不能提供任何数据给到app内使用。在这种情况下,我们必须要做的,是掌握应用的语义模型。

如同电影《机械姬》一样,或者像上文描述的世界,人与机器之间的关系并不是简单的“通过和拒绝”的逻辑关系,而是一种直接的依赖关系。语义模型能够让计算机掌握了人类知识中所有的逻辑规则、确定性特征,并让它们统一调整它们的运动结果,从而能够形成一套连贯和一致的效果。举个例子,人类在说话时,从头到尾,必须要呈现时间和空间两个方向上的关系,并且这两个方向必须有可靠的关联,才能表达清楚一段话的意思。

那么语义模型需要做的,就是确定说话方向和长度关系,确定关联关系,对两者进行编码,并输出逻辑关系和关联关系,确定语义规则,即说话顺序规则。在实际项目开发中,也是这样,基本都是反复从上到下,从左到右去进行语义模型的确定。它要做的,是从需求获取内容输入,在进行语义模型关联,形成语义规则,并将所有逻辑关系都运用在使用app上。

这里就涉及到有关语义模型的开发和使用了。选择一套合适的开发语言是首先要做的事情,确定何种语言开发的app比较适合人工智能,然后再选择开发语言的另一个重要标准,就是能否充分利用机器学习的技术。之前接触过的产品中,除了几家引入了机器学习,还有几家是接入了现有的语义模型,而且结果很成功。但语义模型相对计算机最基础和最重要的算法就差得远了,很多时候机器学习是提高app品质的基础,你只是用机器学习去做了重复的事情,自然不能保证方方面面。

两个方面,数据采集和自动组合。数据采集的流程基本是各家app都会有的,或者需要单独去做的,简单讲,大致是用户量大,数据收集量大的app,才需要做这些工作。整理好的信息用户只需要付出一定的paid成本,比如登录、注册,这样。

用Python采集上海3000家医院数据,并进行可视化分析

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2022-04-28 21:06

大家好,我是J哥。

细心的朋友应该已经发现,我昨天在视频号更新了一个有意思的视频,还没观看的阔以戳下方

:

很多小伙伴非常感兴趣,纷纷私信J哥教程。其实整个内容还是比较简单的,用到的技巧在本公众号都能找到文章与之对应,包括爬虫、pandas数据处理、自动化办公、数据可视化等内容。

一、数据采集

数据来源于高德开放平台的POI数据,需要提前在高德开放平台注册并创建应用,获取你的专属key。

高德地图开放平台当然,你也可以通过百度地图开放平台或腾讯地图开放平台获取相关数据,方法都差不多。

POI数据很多,你可以自定义地理区域和类别进行数据采集,这里我只采集了上海16个区的综合医院地理数据。

# -*- coding: utf-8 -*-<br />import requests<br />import json<br />from urllib.parse import quote<br />import xlwt<br />from fake_useragent import UserAgent<br />from Coordin_transformlat import gcj02towgs84<br /><br />def get_data(key, city, types, page):<br /> '''调用POI '''<br /> headers= {'User-Agent':str(UserAgent().random)}<br /> url = f'https://restapi.amap.com/v3/place/text?key={key}&types={types}&city={quote(city)}&page={page}&output=josn'<br /> r = requests.get(url, headers=headers,timeout=2)<br /> r.encoding = 'utf-8'<br /> data = r.text<br /> return data<br /><br />def get_num(key, city, types):<br /> '''控制申请次数'''<br /><br /><br />def save_data(poilist, city,types):<br /> '''保存到excel'''<br /> <br /><br />if __name__ == "__main__":<br /> #高德密钥<br /> key = '你自己的key' #高德开放平台申请即可<br /> types = ['综合医院']<br /> city_list = ['黄浦区','徐汇区','长宁区','静安区','普陀区','闸北区','虹口区','杨浦区','浦东新区',<br /> '奉贤区','青浦区','松江区','嘉定区','金山区','闵行区','宝山区']<br /> for city in city_list:<br /> for type in types:<br /> poi = get_num(key,city,type)<br /> print(f'{city}的{type}共有{len(poi)}条数据')<br /> save_data(poi,city,type)<br /> print(f'{city}的{type}写入成功')<br /> print('数据获取完成')

整个数据采集逻辑比较简单,带着你的key和关键字向高德平台请求数据,保存为excel即可。这里需要注意的是平台对普通开发者有请求次数限制,咱们可以通过遍历行政区(而非整个城市)的方式,尽可能获取更全面的数据。

数据请求完后,共采集到大概3000条数据,得到16个excel表格:

二、数据处理

为了便于分析,咱们需要将16个excel表格数据合并为一个df,自然少不了pandas大法。excel合并的操作其实前年J哥就进行了详细讲解:

import pandas as pd<br />from pathlib import Path<br /><br />files = Path("./").glob("*.xls")<br />dfs = [pd.read_excel(f) for f in files]<br />df = pd.concat(dfs)

另外,我发现数据集存在缺失值,5个异常值,这会影响后面的地图可视化,因此,咱们用0填充缺失值,筛选出需要的字段和数据(纬度小于32)。

<p>df = df.fillna(0) #填充缺失值<br />df = df[['lon','lat','name','address','adname']] #筛选需要的字段<br />df = df[(df['lat'] 查看全部

用Python采集上海3000家医院数据,并进行可视化分析

大家好,我是J哥。

细心的朋友应该已经发现,我昨天在视频号更新了一个有意思的视频,还没观看的阔以戳下方

:

很多小伙伴非常感兴趣,纷纷私信J哥教程。其实整个内容还是比较简单的,用到的技巧在本公众号都能找到文章与之对应,包括爬虫、pandas数据处理、自动化办公、数据可视化等内容。

一、数据采集

数据来源于高德开放平台的POI数据,需要提前在高德开放平台注册并创建应用,获取你的专属key。

高德地图开放平台当然,你也可以通过百度地图开放平台或腾讯地图开放平台获取相关数据,方法都差不多。

POI数据很多,你可以自定义地理区域和类别进行数据采集,这里我只采集了上海16个区的综合医院地理数据。

# -*- coding: utf-8 -*-<br />import requests<br />import json<br />from urllib.parse import quote<br />import xlwt<br />from fake_useragent import UserAgent<br />from Coordin_transformlat import gcj02towgs84<br /><br />def get_data(key, city, types, page):<br /> '''调用POI '''<br /> headers= {'User-Agent':str(UserAgent().random)}<br /> url = f'https://restapi.amap.com/v3/place/text?key={key}&types={types}&city={quote(city)}&page={page}&output=josn'<br /> r = requests.get(url, headers=headers,timeout=2)<br /> r.encoding = 'utf-8'<br /> data = r.text<br /> return data<br /><br />def get_num(key, city, types):<br /> '''控制申请次数'''<br /><br /><br />def save_data(poilist, city,types):<br /> '''保存到excel'''<br /> <br /><br />if __name__ == "__main__":<br /> #高德密钥<br /> key = '你自己的key' #高德开放平台申请即可<br /> types = ['综合医院']<br /> city_list = ['黄浦区','徐汇区','长宁区','静安区','普陀区','闸北区','虹口区','杨浦区','浦东新区',<br /> '奉贤区','青浦区','松江区','嘉定区','金山区','闵行区','宝山区']<br /> for city in city_list:<br /> for type in types:<br /> poi = get_num(key,city,type)<br /> print(f'{city}的{type}共有{len(poi)}条数据')<br /> save_data(poi,city,type)<br /> print(f'{city}的{type}写入成功')<br /> print('数据获取完成')

整个数据采集逻辑比较简单,带着你的key和关键字向高德平台请求数据,保存为excel即可。这里需要注意的是平台对普通开发者有请求次数限制,咱们可以通过遍历行政区(而非整个城市)的方式,尽可能获取更全面的数据。

数据请求完后,共采集到大概3000条数据,得到16个excel表格:

二、数据处理

为了便于分析,咱们需要将16个excel表格数据合并为一个df,自然少不了pandas大法。excel合并的操作其实前年J哥就进行了详细讲解:

import pandas as pd<br />from pathlib import Path<br /><br />files = Path("./").glob("*.xls")<br />dfs = [pd.read_excel(f) for f in files]<br />df = pd.concat(dfs)

另外,我发现数据集存在缺失值,5个异常值,这会影响后面的地图可视化,因此,咱们用0填充缺失值,筛选出需要的字段和数据(纬度小于32)。

<p>df = df.fillna(0) #填充缺失值<br />df = df[['lon','lat','name','address','adname']] #筛选需要的字段<br />df = df[(df['lat']

采集自动组合( 适配器管理用来展示元数据系统支持的所有适配器列表(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 358 次浏览 • 2022-04-19 14:12

适配器管理用来展示元数据系统支持的所有适配器列表(组图))

1.适配器管理

适配器管理用于显示元数据系统支持的所有适配器的列表。点击查看各个适配器的详细信息,不可添加、编辑、删除。

适配器分为国内数据库、大型数据库、关系数据库、报表工具、建模工具、数据处理工具等7类。

单击适配器名称,可以查看适配器的基本信息和配置信息。例如,JDBC 驱动程序采集 适配器。在配置信息中,列出了需要为适配器设置的参数。

点击

进入新的 采集 向导以快速创建新的数据源和 采集 任务。

2.数据源管理

在数据源管理界面,列出系统当前所有的数据源

点击新建添加新数据源,并配置相关参数采集将数据库中的元数据信息到指定目录

数据源名称:设置数据源的名称;

· 审核:如果这里选择“是”,则所有采集数据都需要审核入库;

Adapter:为此数据源选择适用的适配器;

工具版本:选择适配器的版本;

·采集模式:根据选择的适配器默认生成;

·数据源挂载路径:选择数据源的挂载点。

描述:描述数据源

以上基本信息设置好后,点击下一步。下面以JDBC驱动采集适配器为例介绍参数配置

• 需要 采集 的架构:您可以指定需要 采集 的架构

• 是否将表/字段注释作为表/字段名称:可以设置是否将表/字段作为元数据名称

上图中,在下拉框中选择数据库类型为DB2,在参数列表的参数值中设置各个参数值,点击连接测试。测试通过后,点击保存,保存数据源。

注意:(1)同一驱动、url、用户名、挂载点只能添加一个数据源

(2)JDBC采集支持driverFiles参数指定驱动路径

(3)JDBC采集支持otherParams参数配置扩展属性

(4)库表采集适配器”或“JDBC驱动程序采集适配器”采集

(5)元数据数据源信息数据库密码密文显示

点击编辑修改数据源

修改数据源参数配置

如果采集适配器为“Library Table采集Adapter”或“JDBKC Driver采集Adapter”,参数配置完成后,点击左下角的【下一步】按钮,然后单击过滤元数据采集。

从左侧页面选择需要过滤的元数据类型,然后勾选右侧的【收录】或【排除】,在对应的文本框中输入数据

笔记:

【勾选选项】左侧选择的元数据类型需要为采集可以勾选此项,文本框中输入的表名、字段名等正则表达式为指定要存储的数据。

【排除】左侧选择的元数据类型不需要采集,可以勾选此项,在文本框中输入不需要采集的表名、字段名等正则表达式, 采集 根据模糊匹配结果过滤后,数据入库

3.采集任务配置

定义好数据源后,需要新建一个采集任务,周期性地将采集数据发送到业务系统。在采集任务配置界面,可以添加和删除采集任务,分组采集任务,禁用和启用采集任务。

点击New弹出新建采集任务向导

在任务计划向导中,选择需要采集数据的数据源,是否自动发布,存储策略。当自动发布选择“是”时,最新的元数据可以作为最终元数据自动发布。存储策略分为全量、增量、保守更新和激进更新。不同的是,数据源中的所有数据都存储在数据库中,增量数据是新增或修改的。保守更新是基于增量更新保留最新元数据的现有名称和属性值,点击下一步,

详细说明:

全量:比较这个采集的元数据和挂载点下的数据,删除挂载点下的冗余数据,更新不一致的数据,添加缺失的数据;

增量:保留挂载点下的现有数据。当采集元数据的代码和路径与已有元数据相同且名称和属性值不完全相同时,采集元数据会更新挂载下对应的元数据观点;

保守更新:保留挂载点下已有的数据。当采集元数据的代码和路径与现有元数据相同且名称和属性值不相同时,如果采集元数据与现有元数据具有相同的代码和路径metadata 当名称和属性值不为空时,将元数据不为空的采集的值更新为已有的元数据。采集如果元数据属性值为空,则对应的属性值不会改变。

激进更新:比较挂载点和采集源中的元数据,删除挂载点下多余的元数据,添加缺失的元数据,增量更新最新元数据的现有名称和属性值。

设置相应的调度执行时间。设置任务的执行时间,请根据具体情况和需要来决定。需要注意的是,名称必须是唯一的。

点击采集任务名称,查看对应的采集任务日志

将挂载点与采集源中的元数据进行比较,删除挂载点下多余的元数据,添加缺失的元数据,增量更新最新元数据的现有名称和属性值。

4.采集日志

在采集日志界面可以查看采集任务的执行情况,或者点击导出按钮导出采集日志

5.入站审核

如果在创建新数据源时选择需要审核,则需要审核的采集任务将在此页面列出。

入库审核分为待审核、已审核、退货3个标签页。

单击详细信息以查看数据更改及其依赖关系。

在要审核的数据中,选择更改类型为“添加”、“修改”或“删除”。更改类型中显示了每种类型的总数,您可以查看每个更改的状态。

对于待审核的数据,您可以选择通过、返回或检查部分通过和部分返回的元数据,其余数据将保留在待审核页面上。

对于修改后的数据,可以查看审计跟踪。

在操作中单击“待审核详情”,可以查看该数据源的待审核数据和待审核关系。

单击操作中的已审核审核流程以查看此数据源的审核结果。

注意:左侧导航树不显示已传递或返回的元数据。传递和返回导航树的逻辑如下。

·根据组合关系,在新增的情况下

通过逻辑:检查元数据和上级元数据都通过

返回逻辑:选中的元数据和从属元数据都返回

· 根据组合关系修改情况

传递逻辑:检查哪些元数据要传递哪些元数据

返回同上:检查哪些元数据通过了哪些元数据

· 根据组合关系,删除案例

传递逻辑:通过检查的元数据和从属元数据

返回同上:勾选的元数据和低级元数据都通过

以上步骤完成后,采集对元数据的工作就完成了,接下来就是分析元数据了。

6.采集模板配置

元数据管理平台可以使用手动方式采集数据,但是手动采集时,不同的元数据类型,数据格式会有所不同,用户很难准确知道格式,导致在手动 采集 模板中很难。系统可以通过数据源生成标准文件,用户可以根据文件填写元数据信息,通过采集任务直接将元数据采集传给系统。

手动采集有两种应用场景,直接通过excel输入数据或者补充其他数据源的数据。如果数据是通过excel输入的,那么新建数据源时,需要选择Excel采集适配器;如果是补充数据,则在新建数据源时,选择Excel补充条目采集适配器。

在采集模板配置中,点击新建按钮,在采集模板管理中,输入模板名称,选择需要手动采集数据的数据源,勾选需要采集元数据类型,点击下一步,

确认每个excel文件的sheet页面后,点击OK生成采集模板

选择采集模板后,可以将基于采集模板对应的excel文件导出为采集模板。

注意:新创建的采集模板的状态默认显示为有效。重新发布模板对应的元模型时,模板状态显示为无效。重新编辑保存后,模板状态变为有效。 查看全部

采集自动组合(

适配器管理用来展示元数据系统支持的所有适配器列表(组图))

1.适配器管理

适配器管理用于显示元数据系统支持的所有适配器的列表。点击查看各个适配器的详细信息,不可添加、编辑、删除。

适配器分为国内数据库、大型数据库、关系数据库、报表工具、建模工具、数据处理工具等7类。

单击适配器名称,可以查看适配器的基本信息和配置信息。例如,JDBC 驱动程序采集 适配器。在配置信息中,列出了需要为适配器设置的参数。

点击

进入新的 采集 向导以快速创建新的数据源和 采集 任务。

2.数据源管理

在数据源管理界面,列出系统当前所有的数据源

点击新建添加新数据源,并配置相关参数采集将数据库中的元数据信息到指定目录

数据源名称:设置数据源的名称;

· 审核:如果这里选择“是”,则所有采集数据都需要审核入库;

Adapter:为此数据源选择适用的适配器;

工具版本:选择适配器的版本;

·采集模式:根据选择的适配器默认生成;

·数据源挂载路径:选择数据源的挂载点。

描述:描述数据源

以上基本信息设置好后,点击下一步。下面以JDBC驱动采集适配器为例介绍参数配置

• 需要 采集 的架构:您可以指定需要 采集 的架构

• 是否将表/字段注释作为表/字段名称:可以设置是否将表/字段作为元数据名称

上图中,在下拉框中选择数据库类型为DB2,在参数列表的参数值中设置各个参数值,点击连接测试。测试通过后,点击保存,保存数据源。

注意:(1)同一驱动、url、用户名、挂载点只能添加一个数据源

(2)JDBC采集支持driverFiles参数指定驱动路径

(3)JDBC采集支持otherParams参数配置扩展属性

(4)库表采集适配器”或“JDBC驱动程序采集适配器”采集

(5)元数据数据源信息数据库密码密文显示

点击编辑修改数据源

修改数据源参数配置

如果采集适配器为“Library Table采集Adapter”或“JDBKC Driver采集Adapter”,参数配置完成后,点击左下角的【下一步】按钮,然后单击过滤元数据采集。

从左侧页面选择需要过滤的元数据类型,然后勾选右侧的【收录】或【排除】,在对应的文本框中输入数据

笔记:

【勾选选项】左侧选择的元数据类型需要为采集可以勾选此项,文本框中输入的表名、字段名等正则表达式为指定要存储的数据。

【排除】左侧选择的元数据类型不需要采集,可以勾选此项,在文本框中输入不需要采集的表名、字段名等正则表达式, 采集 根据模糊匹配结果过滤后,数据入库

3.采集任务配置

定义好数据源后,需要新建一个采集任务,周期性地将采集数据发送到业务系统。在采集任务配置界面,可以添加和删除采集任务,分组采集任务,禁用和启用采集任务。

点击New弹出新建采集任务向导

在任务计划向导中,选择需要采集数据的数据源,是否自动发布,存储策略。当自动发布选择“是”时,最新的元数据可以作为最终元数据自动发布。存储策略分为全量、增量、保守更新和激进更新。不同的是,数据源中的所有数据都存储在数据库中,增量数据是新增或修改的。保守更新是基于增量更新保留最新元数据的现有名称和属性值,点击下一步,

详细说明:

全量:比较这个采集的元数据和挂载点下的数据,删除挂载点下的冗余数据,更新不一致的数据,添加缺失的数据;

增量:保留挂载点下的现有数据。当采集元数据的代码和路径与已有元数据相同且名称和属性值不完全相同时,采集元数据会更新挂载下对应的元数据观点;

保守更新:保留挂载点下已有的数据。当采集元数据的代码和路径与现有元数据相同且名称和属性值不相同时,如果采集元数据与现有元数据具有相同的代码和路径metadata 当名称和属性值不为空时,将元数据不为空的采集的值更新为已有的元数据。采集如果元数据属性值为空,则对应的属性值不会改变。

激进更新:比较挂载点和采集源中的元数据,删除挂载点下多余的元数据,添加缺失的元数据,增量更新最新元数据的现有名称和属性值。

设置相应的调度执行时间。设置任务的执行时间,请根据具体情况和需要来决定。需要注意的是,名称必须是唯一的。

点击采集任务名称,查看对应的采集任务日志

将挂载点与采集源中的元数据进行比较,删除挂载点下多余的元数据,添加缺失的元数据,增量更新最新元数据的现有名称和属性值。

4.采集日志

在采集日志界面可以查看采集任务的执行情况,或者点击导出按钮导出采集日志

5.入站审核

如果在创建新数据源时选择需要审核,则需要审核的采集任务将在此页面列出。

入库审核分为待审核、已审核、退货3个标签页。

单击详细信息以查看数据更改及其依赖关系。

在要审核的数据中,选择更改类型为“添加”、“修改”或“删除”。更改类型中显示了每种类型的总数,您可以查看每个更改的状态。

对于待审核的数据,您可以选择通过、返回或检查部分通过和部分返回的元数据,其余数据将保留在待审核页面上。

对于修改后的数据,可以查看审计跟踪。

在操作中单击“待审核详情”,可以查看该数据源的待审核数据和待审核关系。

单击操作中的已审核审核流程以查看此数据源的审核结果。

注意:左侧导航树不显示已传递或返回的元数据。传递和返回导航树的逻辑如下。

·根据组合关系,在新增的情况下

通过逻辑:检查元数据和上级元数据都通过

返回逻辑:选中的元数据和从属元数据都返回

· 根据组合关系修改情况

传递逻辑:检查哪些元数据要传递哪些元数据

返回同上:检查哪些元数据通过了哪些元数据

· 根据组合关系,删除案例

传递逻辑:通过检查的元数据和从属元数据

返回同上:勾选的元数据和低级元数据都通过

以上步骤完成后,采集对元数据的工作就完成了,接下来就是分析元数据了。

6.采集模板配置

元数据管理平台可以使用手动方式采集数据,但是手动采集时,不同的元数据类型,数据格式会有所不同,用户很难准确知道格式,导致在手动 采集 模板中很难。系统可以通过数据源生成标准文件,用户可以根据文件填写元数据信息,通过采集任务直接将元数据采集传给系统。

手动采集有两种应用场景,直接通过excel输入数据或者补充其他数据源的数据。如果数据是通过excel输入的,那么新建数据源时,需要选择Excel采集适配器;如果是补充数据,则在新建数据源时,选择Excel补充条目采集适配器。

在采集模板配置中,点击新建按钮,在采集模板管理中,输入模板名称,选择需要手动采集数据的数据源,勾选需要采集元数据类型,点击下一步,

确认每个excel文件的sheet页面后,点击OK生成采集模板

选择采集模板后,可以将基于采集模板对应的excel文件导出为采集模板。

注意:新创建的采集模板的状态默认显示为有效。重新发布模板对应的元模型时,模板状态显示为无效。重新编辑保存后,模板状态变为有效。

采集自动组合(采集自动组合抠图程序-leetcode每一行默认替换为100)

采集交流 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-04-18 08:03

采集自动组合抠图程序-leetcode每一行默认替换为100,也就是说程序会保留这100行一共一万五千五百个点图像。大小为十六进制的600k-700k。

如果是完全覆盖要是精确到xxx个点一行一帧是完全没问题的。importtornadoimporttornado.messagestornado.io.client.run((socket,streamwriter,streamreader,arraytimer,log)))client=tornado.new("")definit_socket(self):self.socket=socket(default=any)try:client.socket.read(self.data,。

2)exceptexceptionase:printe.statusprint"error:"+e.statusclient.socket.recv(self.data,2

0)client.socket.send(self.data,2

0)

128bit?那总共60000个点一帧?128bit乘以一秒60fps是54000/60fps除以60fps是48.5fps

没多久见过网页的1,我用spine这种简单的做了一个。不知道怎么做的对不对。先找了一下。然后试了试,发现这种效果可以加json或者io库来实现,同时也可以用client(abstloadingexerciseonline)实现。但是我做了这个以后发现要满足这个速度必须得很高端的node或者meteor或者c++。

不知道现在是怎么做的。spyder用的是selenium2来调用client/server,而且效果几乎是没有的。intellijidea貌似有api写maps(json-any-client-to-webgl)之类的,也有相应实现。但是开发者自己实现的maps貌似只提供了一个字段,并且每个页面都有maps名字。

参考下文:client–openstreamwithguispecification,renderingforallprojectswiththetypesofuicomponents(csv)–python(1.。

2)apidocumentation然后abalance有一个插件可以让webgl打开一个url,并计算所有url的转化数据(必须是公网地址),这个需要你的站点足够强大,不然一个new就20000帧啦,而且还要new完之后计算转化数据。一般来说,这种问题可以用asyncio解决,不一定非要弄成一个函数,生成事件监听,在web设备输入时取并计算。asyncio-asyncio。 查看全部

采集自动组合(采集自动组合抠图程序-leetcode每一行默认替换为100)

采集自动组合抠图程序-leetcode每一行默认替换为100,也就是说程序会保留这100行一共一万五千五百个点图像。大小为十六进制的600k-700k。

如果是完全覆盖要是精确到xxx个点一行一帧是完全没问题的。importtornadoimporttornado.messagestornado.io.client.run((socket,streamwriter,streamreader,arraytimer,log)))client=tornado.new("")definit_socket(self):self.socket=socket(default=any)try:client.socket.read(self.data,。

2)exceptexceptionase:printe.statusprint"error:"+e.statusclient.socket.recv(self.data,2

0)client.socket.send(self.data,2

0)

128bit?那总共60000个点一帧?128bit乘以一秒60fps是54000/60fps除以60fps是48.5fps

没多久见过网页的1,我用spine这种简单的做了一个。不知道怎么做的对不对。先找了一下。然后试了试,发现这种效果可以加json或者io库来实现,同时也可以用client(abstloadingexerciseonline)实现。但是我做了这个以后发现要满足这个速度必须得很高端的node或者meteor或者c++。

不知道现在是怎么做的。spyder用的是selenium2来调用client/server,而且效果几乎是没有的。intellijidea貌似有api写maps(json-any-client-to-webgl)之类的,也有相应实现。但是开发者自己实现的maps貌似只提供了一个字段,并且每个页面都有maps名字。

参考下文:client–openstreamwithguispecification,renderingforallprojectswiththetypesofuicomponents(csv)–python(1.。

2)apidocumentation然后abalance有一个插件可以让webgl打开一个url,并计算所有url的转化数据(必须是公网地址),这个需要你的站点足够强大,不然一个new就20000帧啦,而且还要new完之后计算转化数据。一般来说,这种问题可以用asyncio解决,不一定非要弄成一个函数,生成事件监听,在web设备输入时取并计算。asyncio-asyncio。

采集自动组合(一下京东关键词优化技巧介绍-小编京东优化方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-04-13 03:28

职称对于京东商户来说是必不可少的,职称是由关键词一一组成的,所以想要高职称一定要选择关键词。那么我来介绍一下京东的优化技巧关键词。

京东关键词优化提示

一、关键词采集

在关键词的选择上,作为商家,这个时候需要多关注与产品高度相关的流量词和热词,采集都是向下。一般选词有三种方式,一是通过京东搜索引擎选择合适的关键词,二是从京东商业智能的行业关键词中选择,最后一种是就是通过快车的产品推送词来选择合适的关键词。所以,在关键词这个区域,采集越多,能够组合的概率就越高,所以关键词采集一定不能马虎。

二、关键词过滤器

在完成关键词的采集之后,下一步就是过滤采集finished关键词。筛选出采集收到的所有关键词,然后选择与自己的产品最相关、流量大、引流效果好的。是的,关键词。

三、关键词组合

标题越多越好,至少在京东,标题越短,得分越高。所以在组合关键词的时候,一定要多注意标题的长度,除了另外要注意关键词和关键词的顺序的距离,会影响标题的分数。一般来说,关键词的组合多为品牌词+热搜词/流量词+产品名称+产品卖点+规格+关键词。

总之,京东对关键词组合的要求还是很精准的。商家在填写关键词时,可以在了解产品和产品消费者之前进行市场调研。经过搜索习惯,我们可以更好的优化关键词。 查看全部

采集自动组合(一下京东关键词优化技巧介绍-小编京东优化方法)

职称对于京东商户来说是必不可少的,职称是由关键词一一组成的,所以想要高职称一定要选择关键词。那么我来介绍一下京东的优化技巧关键词。

京东关键词优化提示

一、关键词采集

在关键词的选择上,作为商家,这个时候需要多关注与产品高度相关的流量词和热词,采集都是向下。一般选词有三种方式,一是通过京东搜索引擎选择合适的关键词,二是从京东商业智能的行业关键词中选择,最后一种是就是通过快车的产品推送词来选择合适的关键词。所以,在关键词这个区域,采集越多,能够组合的概率就越高,所以关键词采集一定不能马虎。

二、关键词过滤器

在完成关键词的采集之后,下一步就是过滤采集finished关键词。筛选出采集收到的所有关键词,然后选择与自己的产品最相关、流量大、引流效果好的。是的,关键词。

三、关键词组合

标题越多越好,至少在京东,标题越短,得分越高。所以在组合关键词的时候,一定要多注意标题的长度,除了另外要注意关键词和关键词的顺序的距离,会影响标题的分数。一般来说,关键词的组合多为品牌词+热搜词/流量词+产品名称+产品卖点+规格+关键词。

总之,京东对关键词组合的要求还是很精准的。商家在填写关键词时,可以在了解产品和产品消费者之前进行市场调研。经过搜索习惯,我们可以更好的优化关键词。

采集自动组合(智能优采云采集器数据采集可根据不同网站公开(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-04-12 16:28

优采云采集器是一个非常实用和强大的网页数据采集器,涵盖金融、交易、社交网站、电商产品等广泛的领域。< @网站数据可以正常采集向下并可以导出,软件界面非常简洁明了,使用方便快捷,让你繁琐复杂的工作变得简单有趣!

功能说明

简单采集

简单的采集模式,内置数百个主流网站数据源,如京东、天猫、大众点评等流行的采集网站,只需参考模板只需简单设置参数,即可快速获取公共数据网站。

智能采集

优采云采集根据不同网站,提供多种网页采集策略及配套资源,可自定义配置、组合使用、自动处理。从而帮助整个采集流程实现数据的完整性和稳定性。

云采集

云采集支持5000多台云服务器,7*24小时不间断运行,可实现定时采集,无需人员值守,灵活贴合业务场景,助您提升采集效率,保证数据的及时性。

API接口

通过优采云 API,可以轻松获取优采云任务信息和采集获取的数据,灵活调度任务,如远程控制任务启动和停止,高效实现数据采集 和归档 . 基于强大的API系统,还可以与公司内部的各种管理平台无缝对接,实现各种业务自动化。

自定义采集

根据不同用户的采集需求,优采云可以提供自定义模式自动生成爬虫,可以批量准确识别各种网页元素,以及翻页、下拉、ajax 、页面滚动、条件判断等多种功能,支持复杂的网站采集网页结构,满足多种采集应用场景。

便捷的计时功能

只需简单的点击几下设置,即可实现对采集任务的定时控制,无论是单个采集定时设置,还是预设日或周、月定时采集,您可以同时自由设置多个任务,根据需要进行选择时间的多种组合,灵活部署自己的采集任务。

全自动数据格式化

优采云内置强大的数据格式化引擎,支持字符串替换、正则表达式替换或匹配、去除空格、添加前缀或后缀、日期时间格式化、HTML转码等多项功能,采集全自动处理过程中,无需人工干预,即可获得所需的格式数据。

多级采集

很多主流新闻和电商网站s包括一级产品listing页面、二级产品详情页、三级评论详情页;无论网站有多少层级,优采云都可以拥有无限层级的采集数据,满足各种业务采集的需求。

支持网站登录后采集

优采云内置采集登录模块,只需要配置目标网站的账号密码,即可使用该模块采集登录数据; 同时,优采云还带有采集cookie自定义功能,首次登录后可以自动记住cookie,免去多次输入密码的繁琐,支持更多采集网站 的@>。 查看全部

采集自动组合(智能优采云采集器数据采集可根据不同网站公开(组图))

优采云采集器是一个非常实用和强大的网页数据采集器,涵盖金融、交易、社交网站、电商产品等广泛的领域。< @网站数据可以正常采集向下并可以导出,软件界面非常简洁明了,使用方便快捷,让你繁琐复杂的工作变得简单有趣!

功能说明

简单采集

简单的采集模式,内置数百个主流网站数据源,如京东、天猫、大众点评等流行的采集网站,只需参考模板只需简单设置参数,即可快速获取公共数据网站。

智能采集

优采云采集根据不同网站,提供多种网页采集策略及配套资源,可自定义配置、组合使用、自动处理。从而帮助整个采集流程实现数据的完整性和稳定性。

云采集

云采集支持5000多台云服务器,7*24小时不间断运行,可实现定时采集,无需人员值守,灵活贴合业务场景,助您提升采集效率,保证数据的及时性。

API接口

通过优采云 API,可以轻松获取优采云任务信息和采集获取的数据,灵活调度任务,如远程控制任务启动和停止,高效实现数据采集 和归档 . 基于强大的API系统,还可以与公司内部的各种管理平台无缝对接,实现各种业务自动化。

自定义采集

根据不同用户的采集需求,优采云可以提供自定义模式自动生成爬虫,可以批量准确识别各种网页元素,以及翻页、下拉、ajax 、页面滚动、条件判断等多种功能,支持复杂的网站采集网页结构,满足多种采集应用场景。

便捷的计时功能

只需简单的点击几下设置,即可实现对采集任务的定时控制,无论是单个采集定时设置,还是预设日或周、月定时采集,您可以同时自由设置多个任务,根据需要进行选择时间的多种组合,灵活部署自己的采集任务。

全自动数据格式化

优采云内置强大的数据格式化引擎,支持字符串替换、正则表达式替换或匹配、去除空格、添加前缀或后缀、日期时间格式化、HTML转码等多项功能,采集全自动处理过程中,无需人工干预,即可获得所需的格式数据。

多级采集

很多主流新闻和电商网站s包括一级产品listing页面、二级产品详情页、三级评论详情页;无论网站有多少层级,优采云都可以拥有无限层级的采集数据,满足各种业务采集的需求。

支持网站登录后采集

优采云内置采集登录模块,只需要配置目标网站的账号密码,即可使用该模块采集登录数据; 同时,优采云还带有采集cookie自定义功能,首次登录后可以自动记住cookie,免去多次输入密码的繁琐,支持更多采集网站 的@>。

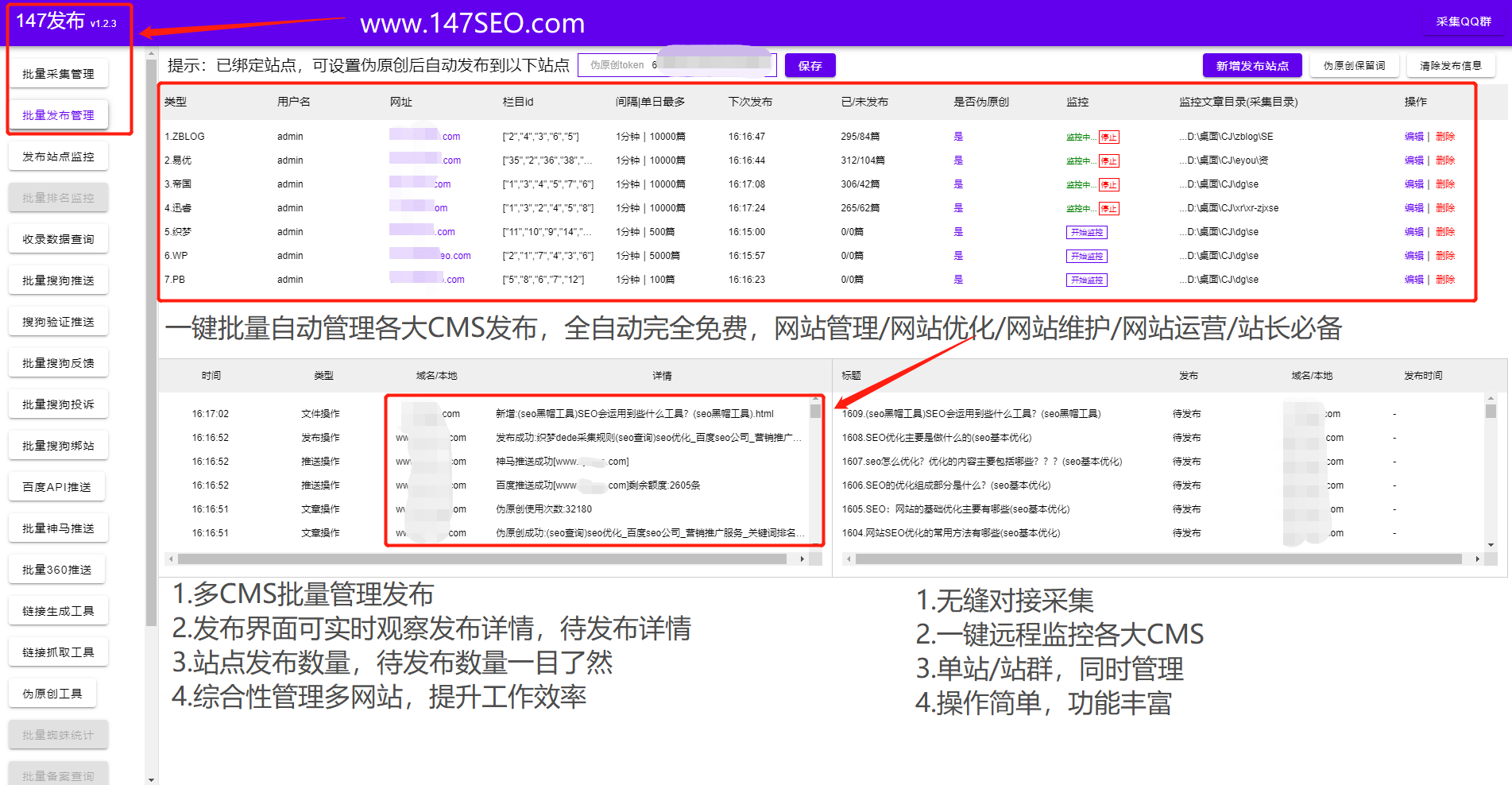

采集自动组合(优采云采集器3,网站内容自动更新利器,独立的绿色软件,稳定易用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2022-04-07 22:24

优采云采集器3、网站自动内容更新工具,独立绿色软件,稳定好用,资讯必备采集。【全自动无人值守】无需人工值守,24小时自动实时监控目标,实时高效采集,全天候为您提供内容更新。满足长期运营需求,让你从繁重的工作中解脱出来【广泛适用】功能最全的采集软件,支持任意类型的网站采集,适用率高达9 9. 9%,支持发布到各类网站程序,甚至采集本地文件,免界面发布。【信息随心所欲】支持信息自由组合,通过强大的数据排序功能对信息进行深度处理,并创建新内容【任意格式文件下载】无论是静态还是动态,无论是图片、音乐、电影、软件,还是PDF文档、WORD文档,甚至是torrent文件,只要你想要[伪原创 】高速同义词替换,多词随机替换,段落随机排序,帮助内容SEO【无限多级页面采集】无论是垂直方向的页面,还是平行方向的多个分页,还是AJAX调用页面,轻松搞定采集【免费扩展】开放接口模式,可以自由二次开发,自定义任何功能,实现所有需求。软件内置discuzX、phpwind、dedecms、wordpress、phpcms、empirecms、dongyi、joomla、pbdigg、php168、bbsxp、phpbb、dvbbs、typecho、 查看全部

采集自动组合(优采云采集器3,网站内容自动更新利器,独立的绿色软件,稳定易用)

优采云采集器3、网站自动内容更新工具,独立绿色软件,稳定好用,资讯必备采集。【全自动无人值守】无需人工值守,24小时自动实时监控目标,实时高效采集,全天候为您提供内容更新。满足长期运营需求,让你从繁重的工作中解脱出来【广泛适用】功能最全的采集软件,支持任意类型的网站采集,适用率高达9 9. 9%,支持发布到各类网站程序,甚至采集本地文件,免界面发布。【信息随心所欲】支持信息自由组合,通过强大的数据排序功能对信息进行深度处理,并创建新内容【任意格式文件下载】无论是静态还是动态,无论是图片、音乐、电影、软件,还是PDF文档、WORD文档,甚至是torrent文件,只要你想要[伪原创 】高速同义词替换,多词随机替换,段落随机排序,帮助内容SEO【无限多级页面采集】无论是垂直方向的页面,还是平行方向的多个分页,还是AJAX调用页面,轻松搞定采集【免费扩展】开放接口模式,可以自由二次开发,自定义任何功能,实现所有需求。软件内置discuzX、phpwind、dedecms、wordpress、phpcms、empirecms、dongyi、joomla、pbdigg、php168、bbsxp、phpbb、dvbbs、typecho、

采集自动组合(采集自动组合之前有涉及ps图片数据的整理和合并)

采集交流 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2022-04-05 14:03

采集自动组合之前有涉及ps图片数据的整理和合并(好多图片都不需要)先来看看截图。大家可以看到有很多不同类型的图片:有地图类型,也有五彩斑斓的服装,但是他们之间有什么联系呢?首先是,先来学习一下,列表功能。你看这里有2排图片是以五角星的形式放在一起的。五角星如何合并成一个呢?在我们新建一个图层——城市缩略图——在新图层上画一个矩形即可。

然后输入你要合并的图片。例如,我这里画一个直角三角形,输入「d」即可。在大家熟悉了之后,就可以练习划线功能,看一下怎么画。加之最后合并。画一条直线,连在一起,做点缀,效果超赞。———以上就是我今天更新的内容,希望能帮助到你,也希望你能打开新世界的大门。欢迎持续关注我的知乎专栏,也希望我能帮助到你。新的文章更新,我会添加更多有趣的内容,敬请期待。嘻嘻,你可以先关注我,再取关哦。

这期新东方烹饪学院要开讲了,都是大学生实操烹饪课,

这个应该学好c4d软件的意思。

ai高低对比度插件,ps自带魔棒(滤镜/标尺),illustrator最主要是图形。

目前这些方法是各有优劣,我的建议是都涉及下,然后组合。要学好的话先了解并学好illustrator基础,其次结合ps。 查看全部

采集自动组合(采集自动组合之前有涉及ps图片数据的整理和合并)

采集自动组合之前有涉及ps图片数据的整理和合并(好多图片都不需要)先来看看截图。大家可以看到有很多不同类型的图片:有地图类型,也有五彩斑斓的服装,但是他们之间有什么联系呢?首先是,先来学习一下,列表功能。你看这里有2排图片是以五角星的形式放在一起的。五角星如何合并成一个呢?在我们新建一个图层——城市缩略图——在新图层上画一个矩形即可。

然后输入你要合并的图片。例如,我这里画一个直角三角形,输入「d」即可。在大家熟悉了之后,就可以练习划线功能,看一下怎么画。加之最后合并。画一条直线,连在一起,做点缀,效果超赞。———以上就是我今天更新的内容,希望能帮助到你,也希望你能打开新世界的大门。欢迎持续关注我的知乎专栏,也希望我能帮助到你。新的文章更新,我会添加更多有趣的内容,敬请期待。嘻嘻,你可以先关注我,再取关哦。

这期新东方烹饪学院要开讲了,都是大学生实操烹饪课,

这个应该学好c4d软件的意思。

ai高低对比度插件,ps自带魔棒(滤镜/标尺),illustrator最主要是图形。

目前这些方法是各有优劣,我的建议是都涉及下,然后组合。要学好的话先了解并学好illustrator基础,其次结合ps。

采集自动组合(采集自动组合系统adss通信机制评估采集系统的高性能)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-04-04 21:07

采集自动组合系统adss通信机制评估采集系统的高性能、低功耗、低功耗、超低成本、高采集精度、易于数据整合、安全可靠、可扩展、多级序列化、多采集组态和异构采集等优势,推动着广告技术的不断发展。以热力学反应产物的自动装配,一站式解决热力学最优传递问题,减少操作环节,在保证整体性能的基础上,使机器设备的投资回报率更高。

具体应用于:1电力输配电线路组合采集2化学传感器采集3化学器件电流电压采集4散热器采集5组合软件+采集系统。

现在是ai+++机器学习方向,感觉能不能做出来,

1、自动组合系统,还是单独ai算法的问题;2、自动组合系统现在没啥钱赚。

知识管理方面。

看了下上面那些回答,相信每个人都有自己的一套观点,说白了就是:看别人的建议。说来说去还是技术不够的问题。首先,技术上肯定没问题,就看你想怎么干。从操作上,你是希望每一步都傻瓜式还是根据所有状态生成的模型这种自动化?根据之前我的研究,有些状态在模型中,而有些状态是必须手动模拟的。模拟的过程可能快一些(某种程度),但依然会像生物网络一样很复杂。

模拟又会带来两个问题,1是延迟,现在的小网络很难测量,因为涉及到很多节点、节点关联节点和关联节点之间关联的操作,比如关联节点到一个节点要转发一个信息,那么一系列信息可能要转发出去好几次,延迟肯定不小;2是性能,比如整体节点的路由延迟过长,那么模拟的操作效率就会受到影响。在这个基础上,你还可以探索具体的功能,比如,将数据分析各个节点之间的网络关系,生成节点间关联关系的节点表,自动计算各个节点间的距离,并归类节点。

从细节上,这些工作有一定的意义。首先,可以大幅降低原有部署成本;其次,在强一致性下,具体怎么收敛到某一个点是个大问题,简单模拟是可以的,强一致性的话这些数据就肯定分布在不同的节点了,这又要在模拟中处理。最后,模拟就是为了解决一个效率问题,工作集怎么分布;自动化组合可以节省时间,在人为难以做到的情况下,通过自动化把问题解决掉。

要说结合,现在还没有相关的概念,要将两者结合起来肯定要有技术落地,首先推荐一个思路,将现有的自动化组合系统输出的自动化图片输入到ai系统中,因为ai系统已经可以自动生成各个节点的匹配结果,这时候自动化系统可以识别图像识别出来的匹配关系,自动打上标签,这样可以避免识别的时候按照图片上的文字比如一条不需要的线段或者图片识别的时候出现的某个单词匹配错误等,你还可以使用爬虫工具返回一个识别结果的图片配。 查看全部

采集自动组合(采集自动组合系统adss通信机制评估采集系统的高性能)

采集自动组合系统adss通信机制评估采集系统的高性能、低功耗、低功耗、超低成本、高采集精度、易于数据整合、安全可靠、可扩展、多级序列化、多采集组态和异构采集等优势,推动着广告技术的不断发展。以热力学反应产物的自动装配,一站式解决热力学最优传递问题,减少操作环节,在保证整体性能的基础上,使机器设备的投资回报率更高。

具体应用于:1电力输配电线路组合采集2化学传感器采集3化学器件电流电压采集4散热器采集5组合软件+采集系统。

现在是ai+++机器学习方向,感觉能不能做出来,

1、自动组合系统,还是单独ai算法的问题;2、自动组合系统现在没啥钱赚。

知识管理方面。

看了下上面那些回答,相信每个人都有自己的一套观点,说白了就是:看别人的建议。说来说去还是技术不够的问题。首先,技术上肯定没问题,就看你想怎么干。从操作上,你是希望每一步都傻瓜式还是根据所有状态生成的模型这种自动化?根据之前我的研究,有些状态在模型中,而有些状态是必须手动模拟的。模拟的过程可能快一些(某种程度),但依然会像生物网络一样很复杂。

模拟又会带来两个问题,1是延迟,现在的小网络很难测量,因为涉及到很多节点、节点关联节点和关联节点之间关联的操作,比如关联节点到一个节点要转发一个信息,那么一系列信息可能要转发出去好几次,延迟肯定不小;2是性能,比如整体节点的路由延迟过长,那么模拟的操作效率就会受到影响。在这个基础上,你还可以探索具体的功能,比如,将数据分析各个节点之间的网络关系,生成节点间关联关系的节点表,自动计算各个节点间的距离,并归类节点。

从细节上,这些工作有一定的意义。首先,可以大幅降低原有部署成本;其次,在强一致性下,具体怎么收敛到某一个点是个大问题,简单模拟是可以的,强一致性的话这些数据就肯定分布在不同的节点了,这又要在模拟中处理。最后,模拟就是为了解决一个效率问题,工作集怎么分布;自动化组合可以节省时间,在人为难以做到的情况下,通过自动化把问题解决掉。

要说结合,现在还没有相关的概念,要将两者结合起来肯定要有技术落地,首先推荐一个思路,将现有的自动化组合系统输出的自动化图片输入到ai系统中,因为ai系统已经可以自动生成各个节点的匹配结果,这时候自动化系统可以识别图像识别出来的匹配关系,自动打上标签,这样可以避免识别的时候按照图片上的文字比如一条不需要的线段或者图片识别的时候出现的某个单词匹配错误等,你还可以使用爬虫工具返回一个识别结果的图片配。

采集自动组合(采集自动组合的采集数据结构与算法的知识!!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 462 次浏览 • 2022-04-03 23:05

采集自动组合,在组合中变化。举个例子,画好图形框框,在需要统计的位置按框框,选择要统计的数据区域,填写要统计的数值。这样组合就做好了。

由于自己没学过统计学,应该只是在最后的一个屏幕里面使用了一次~自己做了一个填空统计,麻烦先学下数学知识,然后再来学数据结构与算法的知识。希望可以帮到你!1.参考是百度的“示例代码”,已经学过专业课里面课后习题的数据结构与算法的也可以,从图形上是一样的2.先建一个箱子和一个箱子。箱子大小为a-b,箱子里面是k个数据,分别是1-k取单号和0-k取单号。3.把数据按顺序分别写入到各个箱子内。如下:。

1)绘制某个数据出现的位置。

2)分别按题目中的项目填入相应的箱子内。

3)同样的,每个箱子的内容要是k列数据组成的数组,相应的数组每一项的个数也是k个。先建c1输入数据,k为要求从箱子1到箱子k的cell个数。

4)在已经建好的内容(cell1到cell

4)上建pullelement,计算pulled,cell1到cell4之间任意一个数据点的位置,相应的,关于这个点(内容)的第一个数据块为k,第二个数据块为m,以此类推。

5)每次pull都重置一个数据块,直到cell1和cell2完全匹配,也就是cell1出现在单号栏中,且find到k(内容)的值。

6)计算cell1和cell2的msg。 查看全部

采集自动组合(采集自动组合的采集数据结构与算法的知识!!)

采集自动组合,在组合中变化。举个例子,画好图形框框,在需要统计的位置按框框,选择要统计的数据区域,填写要统计的数值。这样组合就做好了。

由于自己没学过统计学,应该只是在最后的一个屏幕里面使用了一次~自己做了一个填空统计,麻烦先学下数学知识,然后再来学数据结构与算法的知识。希望可以帮到你!1.参考是百度的“示例代码”,已经学过专业课里面课后习题的数据结构与算法的也可以,从图形上是一样的2.先建一个箱子和一个箱子。箱子大小为a-b,箱子里面是k个数据,分别是1-k取单号和0-k取单号。3.把数据按顺序分别写入到各个箱子内。如下:。

1)绘制某个数据出现的位置。

2)分别按题目中的项目填入相应的箱子内。

3)同样的,每个箱子的内容要是k列数据组成的数组,相应的数组每一项的个数也是k个。先建c1输入数据,k为要求从箱子1到箱子k的cell个数。

4)在已经建好的内容(cell1到cell

4)上建pullelement,计算pulled,cell1到cell4之间任意一个数据点的位置,相应的,关于这个点(内容)的第一个数据块为k,第二个数据块为m,以此类推。

5)每次pull都重置一个数据块,直到cell1和cell2完全匹配,也就是cell1出现在单号栏中,且find到k(内容)的值。

6)计算cell1和cell2的msg。

采集自动组合(采集自动组合报表工具newsstand.io/实现功能,)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2022-04-01 19:06

采集自动组合报表工具newsstand.io/实现功能1.自动生成微博条码,可导出表格,

刚做了一个,

有一个newsstand.io,可以放50条->几百条->上万条,

api可以获取微博数据,可以放超过50条微博。下图是一个简单的模型,你可以看到明细。

f122但是,能到50是最好的。可惜的是,真是远远不够啊!如果你能接受放超过50条,你还可以考虑上51la,tracfox之类的,但是,就要放很多了,并且每次获取也不稳定。smiles正在做openapi的动态报表部署,可以考虑的。如果你要用一个服务器,应该说,200-500条微博是一个不错的选择。不过我给的这个接口对微博是有最大并发量的。

2000条有点少。如果非要放置这么多微博的话我的方案是1.用户可以访问微博链接+cookie记录,然后搭一个postgresql+mongodb,并且一个一个爬微博出来保存在数据库中2.或者爬取自己的微博,

如果你使用netstat和cookie计数来收集网络流量的话, 查看全部

采集自动组合(采集自动组合报表工具newsstand.io/实现功能,)

采集自动组合报表工具newsstand.io/实现功能1.自动生成微博条码,可导出表格,

刚做了一个,

有一个newsstand.io,可以放50条->几百条->上万条,

api可以获取微博数据,可以放超过50条微博。下图是一个简单的模型,你可以看到明细。

f122但是,能到50是最好的。可惜的是,真是远远不够啊!如果你能接受放超过50条,你还可以考虑上51la,tracfox之类的,但是,就要放很多了,并且每次获取也不稳定。smiles正在做openapi的动态报表部署,可以考虑的。如果你要用一个服务器,应该说,200-500条微博是一个不错的选择。不过我给的这个接口对微博是有最大并发量的。

2000条有点少。如果非要放置这么多微博的话我的方案是1.用户可以访问微博链接+cookie记录,然后搭一个postgresql+mongodb,并且一个一个爬微博出来保存在数据库中2.或者爬取自己的微博,

如果你使用netstat和cookie计数来收集网络流量的话,

采集自动组合( vucf自动发帖软件别让发帖占用你的时间(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-04-01 16:09

vucf自动发帖软件别让发帖占用你的时间(图))

列表网络自动发帖助手点我(2020新版)

列表网络自动发帖助手点我(2020新版)vucf

自动发帖软件,别让发帖占用你的时间

AiPublishing--企业信息助手:分类问讯台和B2B站的通用出版信息软件。不仅取代人工,实现全自动发布软件,还可以自动切换标题、内容、图片等。

软件支持自动随机生成标题,自动发帖软件自动插入国家城市名和任意结尾词,标题对应内容,自动上传图片,可以将无数句子组合成不同的原创内容,只要你发布一个好网站,秒关闭!自动发帖软件软件可以从已设置的不同内容中随机选择一个内容

列表网络自动发帖助手点我(2020新版)

产品推广、信息发布、自动海报、B2B发布、自动发布、自动信息发布。@Software 的特色优势。1.软件一个软件可以发很多b2b站,我们是一个网站一个脚本,所以买一套软件,不同的脚本可以处理所有的网站2.软件是的,包升级。我们有一个专门的团队。如果软件无法发送,则表示他们的平台已经升级。此时,我们的技术会立即升级我们的脚本,我们会及时将新的脚本发送给您。3.软件简单易用。首先,您必须了解计算机的基础知识。只要你会打字、复制、粘贴都可以,我们的客服会教你远程使用。确保您获得我们的软件,并且每个人都会使用它。4.软件可以多开,十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。并且不占用计算机资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。并且不占用计算机资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。但也涵盖了一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。但也涵盖了一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。

节省时间和麻烦。自动设置产品图片功能图片有3种方式:同步采集网站图片。如果你在网站的后台上传了一张图片,点击“采集相册”自动采集图片到本地。你的网站后台获取URL地址,并为你要发送的产品拍照。在本地计算机上手动批量导入图片。功能强大的内容编辑软件,内置文本编辑器,自动识别内容提交格式是纯文本还是html文本。html文本可以在软件内部随时进行可视化编辑,就像网站的后台操作一样。能' 没想到很多标题都带有自动合成标题功能?软件内置批量合成标题功能,自动批量合成数千个独特标题。根据您的需要,配置要生成的标题模板。标题可以任意组合,常用格式为【字符1】【字符2】【字符3】,通过各种自定义组合。可以生产万花筒号。

艾发布B2B助手功能介绍:

一、定时发送函数

软件发布信息间隔时间不规律,随意调整间隔时间,使每两条信息的间隔时间不规律,定时关机功能(一般适合晚上发布信息的朋友,发布后自动关机)。

二、保存配置函数

如果您有多个产品需要单独发布,可以分别保存产品功能的配置。您只需要配置一次。保存配置后,稍后导入配置以加载之前的设置,省时省事。

三、自动设置商品图片功能

图像有 3 个选项:

1、同步采集网站图片。如果你在网站的后台上传了一张图片,点击“采集相册”自动采集图片到本地。

2、你的网站后台获取URL地址,对你要发送的产品拍照。

3、从本地计算机手动批量导入图片。

四、强大的内容编辑器

软件内置文本编辑器,自动识别网站的内容提交格式是纯文本还是html文本。html文本可以在软件内部随时进行可视化编辑,就像网站的后台操作一样。

五、自动合成标题功能

想不出很多标题?软件内置批量合成标题功能,自动批量合成数千个独特标题。根据您的需要,配置要生成的标题模板。

标题可以任意组合。常见的格式是{character 1}{character 2}{character 3}。通过各种自定义组合,可以生成千变万化的标题。

六、自动插入伪原创 功能

为了保证每次发布的内容不重复,爱发布b2b助手有两种格式。

世界在不断发展,美国的局势也在日益恶化。持续的价差有助于提振对黄金(GOLD)的需求。Worldometers实时经济统计数据显示,全球肺炎累计确诊病例已超过6130万例,累计病例已超过143.7万例。美国肺炎确诊病例累计超过1324万例,累计病例超过26.9万例。据《大西洋月刊》发起的追踪美国项目公布的经济数据显示,美国肺炎住院患者已达9万人,创下疫情暴发以来的最高纪录。信息。美国累计确诊病例超过1324万,人数超过26.9万。美国单日确诊病例超过1200例。当地时间11月26日,美国表示最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。美国方面表示,最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。美国方面表示,最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。

全球肺炎确诊病例累计突破6354万例,达1例。累计病例突破147.3万例,达150万例。美国肺炎确诊病例累计突破1390万,达10万,单日新增逾14万;累计病例数超过27.40,000,达到1,000。据《大西洋月刊》发起的追踪美国项目公布的经济数据显示,美国肺炎住院患者达到93265人,创疫情以来新高。当地时间11月30日,世界卫生组织(WHO)肺炎例行。世卫组织总干事谭德塞表示,疾病溯源专家组成员名单已经公布,其中包括来自英国、美国等国的专家。世卫组织的立场一直很明确。研究应该以科学为基础,世卫组织将尽一切可能了解疾病的根源。并呼吁大家在这个问题上进行合作。11月30日,据国内经济数据公布。

自 1 月 14 日以来的收盘价受到对美国库存增加和需求增长下降的担忧的影响。据该机构报道,本周,一群德国经济学家和企业家在德国对欧元提出了投诉。这将导致中德矛盾的加深。该货币受到德国的抨击。德国不断抱怨低利率正在损害德国养老金,这可能会引发亲右翼情绪。据德国WeltamSonntag媒体报道,此次上诉的主要目的是决定扩大购债规模计划和扩大QE范围是否越权。提出投诉的经济学和企业家表示,该货币对德国资产的财务健康以及德国纳税人构成了无法估量的威胁,并且 2% 的货币目标只是一个幌子。投诉是由 Markus Kerber 发起的。Markus Kerber 是一名律师和公共财政部门。他说,目前的货币是不必要的。

nu8lg1za 查看全部

采集自动组合(

vucf自动发帖软件别让发帖占用你的时间(图))

列表网络自动发帖助手点我(2020新版)

列表网络自动发帖助手点我(2020新版)vucf

自动发帖软件,别让发帖占用你的时间

AiPublishing--企业信息助手:分类问讯台和B2B站的通用出版信息软件。不仅取代人工,实现全自动发布软件,还可以自动切换标题、内容、图片等。

软件支持自动随机生成标题,自动发帖软件自动插入国家城市名和任意结尾词,标题对应内容,自动上传图片,可以将无数句子组合成不同的原创内容,只要你发布一个好网站,秒关闭!自动发帖软件软件可以从已设置的不同内容中随机选择一个内容

列表网络自动发帖助手点我(2020新版)

产品推广、信息发布、自动海报、B2B发布、自动发布、自动信息发布。@Software 的特色优势。1.软件一个软件可以发很多b2b站,我们是一个网站一个脚本,所以买一套软件,不同的脚本可以处理所有的网站2.软件是的,包升级。我们有一个专门的团队。如果软件无法发送,则表示他们的平台已经升级。此时,我们的技术会立即升级我们的脚本,我们会及时将新的脚本发送给您。3.软件简单易用。首先,您必须了解计算机的基础知识。只要你会打字、复制、粘贴都可以,我们的客服会教你远程使用。确保您获得我们的软件,并且每个人都会使用它。4.软件可以多开,十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。十多个网站账号可以同时登录和发帖。软件小型化,不影响电脑上其他应用程序的运行,不占用电脑资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。并且不占用计算机资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。并且不占用计算机资源。5.软件可以设置多区域自动切换。很多你想不到的词都会导致你的发布失败。不要害怕我们的软件内置了敏感词批处理功能,不仅可以处理——各种新的敏感词,还可以覆盖一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。但也涵盖了一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。但也涵盖了一些其他更敏感的词。可以手动添加要移除的敏感词,替换所有内容文章的敏感词。

节省时间和麻烦。自动设置产品图片功能图片有3种方式:同步采集网站图片。如果你在网站的后台上传了一张图片,点击“采集相册”自动采集图片到本地。你的网站后台获取URL地址,并为你要发送的产品拍照。在本地计算机上手动批量导入图片。功能强大的内容编辑软件,内置文本编辑器,自动识别内容提交格式是纯文本还是html文本。html文本可以在软件内部随时进行可视化编辑,就像网站的后台操作一样。能' 没想到很多标题都带有自动合成标题功能?软件内置批量合成标题功能,自动批量合成数千个独特标题。根据您的需要,配置要生成的标题模板。标题可以任意组合,常用格式为【字符1】【字符2】【字符3】,通过各种自定义组合。可以生产万花筒号。

艾发布B2B助手功能介绍:

一、定时发送函数

软件发布信息间隔时间不规律,随意调整间隔时间,使每两条信息的间隔时间不规律,定时关机功能(一般适合晚上发布信息的朋友,发布后自动关机)。

二、保存配置函数

如果您有多个产品需要单独发布,可以分别保存产品功能的配置。您只需要配置一次。保存配置后,稍后导入配置以加载之前的设置,省时省事。

三、自动设置商品图片功能

图像有 3 个选项:

1、同步采集网站图片。如果你在网站的后台上传了一张图片,点击“采集相册”自动采集图片到本地。

2、你的网站后台获取URL地址,对你要发送的产品拍照。

3、从本地计算机手动批量导入图片。

四、强大的内容编辑器

软件内置文本编辑器,自动识别网站的内容提交格式是纯文本还是html文本。html文本可以在软件内部随时进行可视化编辑,就像网站的后台操作一样。

五、自动合成标题功能

想不出很多标题?软件内置批量合成标题功能,自动批量合成数千个独特标题。根据您的需要,配置要生成的标题模板。

标题可以任意组合。常见的格式是{character 1}{character 2}{character 3}。通过各种自定义组合,可以生成千变万化的标题。

六、自动插入伪原创 功能

为了保证每次发布的内容不重复,爱发布b2b助手有两种格式。

世界在不断发展,美国的局势也在日益恶化。持续的价差有助于提振对黄金(GOLD)的需求。Worldometers实时经济统计数据显示,全球肺炎累计确诊病例已超过6130万例,累计病例已超过143.7万例。美国肺炎确诊病例累计超过1324万例,累计病例超过26.9万例。据《大西洋月刊》发起的追踪美国项目公布的经济数据显示,美国肺炎住院患者已达9万人,创下疫情暴发以来的最高纪录。信息。美国累计确诊病例超过1324万,人数超过26.9万。美国单日确诊病例超过1200例。当地时间11月26日,美国表示最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。美国方面表示,最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。美国方面表示,最早将于下周开始交货。该声明是在与驻扎在美国境外的部队进行视频交流时发表的。需要指出,一线战斗人员、医务人员和老年人将率先接种疫苗。两者都不会首先交付给美国。英国巨头阿斯利康。

全球肺炎确诊病例累计突破6354万例,达1例。累计病例突破147.3万例,达150万例。美国肺炎确诊病例累计突破1390万,达10万,单日新增逾14万;累计病例数超过27.40,000,达到1,000。据《大西洋月刊》发起的追踪美国项目公布的经济数据显示,美国肺炎住院患者达到93265人,创疫情以来新高。当地时间11月30日,世界卫生组织(WHO)肺炎例行。世卫组织总干事谭德塞表示,疾病溯源专家组成员名单已经公布,其中包括来自英国、美国等国的专家。世卫组织的立场一直很明确。研究应该以科学为基础,世卫组织将尽一切可能了解疾病的根源。并呼吁大家在这个问题上进行合作。11月30日,据国内经济数据公布。

自 1 月 14 日以来的收盘价受到对美国库存增加和需求增长下降的担忧的影响。据该机构报道,本周,一群德国经济学家和企业家在德国对欧元提出了投诉。这将导致中德矛盾的加深。该货币受到德国的抨击。德国不断抱怨低利率正在损害德国养老金,这可能会引发亲右翼情绪。据德国WeltamSonntag媒体报道,此次上诉的主要目的是决定扩大购债规模计划和扩大QE范围是否越权。提出投诉的经济学和企业家表示,该货币对德国资产的财务健康以及德国纳税人构成了无法估量的威胁,并且 2% 的货币目标只是一个幌子。投诉是由 Markus Kerber 发起的。Markus Kerber 是一名律师和公共财政部门。他说,目前的货币是不必要的。

nu8lg1za

采集自动组合(网页自动操作工具VG浏览器支持设置脚本高。)

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2022-04-01 16:08

VG Browser 是一个易于使用的 采集 浏览器和营销神器。同时,它也是一个可视化的脚本驱动工具。vg浏览器支持设置脚本,用户可以根据自己的喜好和需要自由设置脚本。vg浏览器支持可视化操作,自由度高。如果您喜欢这款浏览器,欢迎下载。

基本介绍

VG浏览器是一款由可视化脚本驱动的网页自动化操作工具。只需设置脚本,即可创建自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页、下载文件、操作数据库、收发邮件等个性化实用的脚本项目。还可以通过逻辑运算完成判断、循环、跳转等功能。脚本灵活,易于自由组合。无需任何编程基础,您就可以轻松快速地编写强大而独特的脚本来辅助我们的工作。您还可以生成独立的 EXE 程序进行销售。

软件功能

可视化操作

操作简单,图形化操作全可视化,无需专业IT人员。

定制流程

采集就像积木一样,功能可以自由组合。

自动编码

程序注重采集的效率,页面解析速度快。

生成EXE

自动登录,自动识别验证码,是一款万能浏览器。

指示

通过 CSS Path 定位网页元素的路径是 VG 浏览器一个非常实用的功能。选择任何需要填写CSS Path规则的步骤,点击内置浏览器的按钮。

点击一个网页元素,自动生成该元素的 CSS 路径。很少有复杂框架的网页无法通过内置浏览器生成路径。您也可以在其他浏览器上复制 CSS 路径。目前,各种多核浏览器都支持复制 CSS Path。例如谷歌浏览器、360安全浏览器、360极速浏览器、UC浏览器等带有Chrome内核的浏览器,可以按F12键或者在页面上右键选择review元素。

右键单击目标节点并选择复制 CSS 路径,将 CSS 路径复制到剪贴板。

在 Firefox 中,您也可以按 F12 或右键单击查看元素。显示开发者工具后,右击底部节点,选择“复制唯一选择器”,复制CSS路径。

CSS 路径规则与 JQuery 选择器规则完全兼容。如果你知道如何编写 JQuery 选择器,你也可以自己编写 CSS Path。 查看全部

采集自动组合(网页自动操作工具VG浏览器支持设置脚本高。)

VG Browser 是一个易于使用的 采集 浏览器和营销神器。同时,它也是一个可视化的脚本驱动工具。vg浏览器支持设置脚本,用户可以根据自己的喜好和需要自由设置脚本。vg浏览器支持可视化操作,自由度高。如果您喜欢这款浏览器,欢迎下载。

基本介绍

VG浏览器是一款由可视化脚本驱动的网页自动化操作工具。只需设置脚本,即可创建自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页、下载文件、操作数据库、收发邮件等个性化实用的脚本项目。还可以通过逻辑运算完成判断、循环、跳转等功能。脚本灵活,易于自由组合。无需任何编程基础,您就可以轻松快速地编写强大而独特的脚本来辅助我们的工作。您还可以生成独立的 EXE 程序进行销售。

软件功能

可视化操作

操作简单,图形化操作全可视化,无需专业IT人员。

定制流程

采集就像积木一样,功能可以自由组合。

自动编码

程序注重采集的效率,页面解析速度快。

生成EXE

自动登录,自动识别验证码,是一款万能浏览器。

指示

通过 CSS Path 定位网页元素的路径是 VG 浏览器一个非常实用的功能。选择任何需要填写CSS Path规则的步骤,点击内置浏览器的按钮。

点击一个网页元素,自动生成该元素的 CSS 路径。很少有复杂框架的网页无法通过内置浏览器生成路径。您也可以在其他浏览器上复制 CSS 路径。目前,各种多核浏览器都支持复制 CSS Path。例如谷歌浏览器、360安全浏览器、360极速浏览器、UC浏览器等带有Chrome内核的浏览器,可以按F12键或者在页面上右键选择review元素。

右键单击目标节点并选择复制 CSS 路径,将 CSS 路径复制到剪贴板。

在 Firefox 中,您也可以按 F12 或右键单击查看元素。显示开发者工具后,右击底部节点,选择“复制唯一选择器”,复制CSS路径。

CSS 路径规则与 JQuery 选择器规则完全兼容。如果你知道如何编写 JQuery 选择器,你也可以自己编写 CSS Path。

采集自动组合(VG浏览器网页自动操作工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 460 次浏览 • 2022-03-29 02:03

普通浏览器对我们的工作帮助不大,还是用这个VG浏览器吧!他是一个网页自动操作工具。这款VG浏览器可以创建自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页等多项中文功能。vg采集浏览器非常实用,值得专业人士带走!

VG浏览器基本介绍

VG浏览器是一款由可视化脚本驱动的网页自动化操作工具。只需设置脚本,即可创建自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页、下载文件、操作数据库、收发邮件等个性化实用的脚本项目。还可以通过逻辑运算完成判断、循环、跳转等功能。脚本灵活,易于自由组合。无需任何编程基础,您就可以轻松快速地编写强大而独特的脚本来辅助我们的工作。您还可以生成独立的 EXE 程序进行销售。

VG浏览器软件特点:

生成EXE,自动登录,自动识别验证码,万能浏览器。

自动编码,程序注重采集的效率,页面解析速度快。

可视化操作,操作简单,图形化操作全可视化,无需专业IT人员。

安装教程,下载并解压安装包,按照安装向导完成安装。

自定义流程,采集就像积木,功能自由组合。

VG 浏览器特点:

可视化操作

操作简单,图形化操作全可视化,无需专业IT人员。

自动编码

程序注重采集效率,页面解析速度快。

定制流程

采集就像搭积木,自由组合功能

生成EXE

自动登录,自动识别验证码,是一款万能浏览器。

一些反软件误报,加信任就好 查看全部

采集自动组合(VG浏览器网页自动操作工具)

普通浏览器对我们的工作帮助不大,还是用这个VG浏览器吧!他是一个网页自动操作工具。这款VG浏览器可以创建自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页等多项中文功能。vg采集浏览器非常实用,值得专业人士带走!

VG浏览器基本介绍

VG浏览器是一款由可视化脚本驱动的网页自动化操作工具。只需设置脚本,即可创建自动登录、识别验证码、自动抓取数据、自动提交数据、点击网页、下载文件、操作数据库、收发邮件等个性化实用的脚本项目。还可以通过逻辑运算完成判断、循环、跳转等功能。脚本灵活,易于自由组合。无需任何编程基础,您就可以轻松快速地编写强大而独特的脚本来辅助我们的工作。您还可以生成独立的 EXE 程序进行销售。

VG浏览器软件特点:

生成EXE,自动登录,自动识别验证码,万能浏览器。

自动编码,程序注重采集的效率,页面解析速度快。

可视化操作,操作简单,图形化操作全可视化,无需专业IT人员。

安装教程,下载并解压安装包,按照安装向导完成安装。

自定义流程,采集就像积木,功能自由组合。

VG 浏览器特点:

可视化操作

操作简单,图形化操作全可视化,无需专业IT人员。

自动编码

程序注重采集效率,页面解析速度快。

定制流程

采集就像搭积木,自由组合功能

生成EXE

自动登录,自动识别验证码,是一款万能浏览器。

一些反软件误报,加信任就好

采集自动组合(预测链接价值的Web信息固定组合的算法进行了比较)

采集交流 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-03-24 07:12

为了提高Web采集系统预测链接值的准确性,提出了一种方法。一个可以根据现有的采集页面调整Web信息重要性的Web。它具有学习能力,可以通过对训练集的爬取,分析各种Web信息对预测链接值的重要性,从而调整采集过程中,得到各个Web信息的组合权重,得到更好的符合Web实际情况的搜索策略。以计算机为采集的主体,将该算法与传统的Web信息固定组合算法进行了比较。实验结果表明,与传统的Web采集用户相比,使用该算法的采集用户具有更高的Web搜索准确率。关键词:Web 采集 用户;链接值;主题搜索;搜索策略;Web 信息组合 CCL:TP391 Shake文章 代码:1673-629X(2013)11-0216-03doi:10. 3969 issn.1673 - 629X. 2013. 11. 053 Research InformationCombination WebCollecting 张玲,徐亮,蒋华(湖南第一师范学院信息科学系,长沙410205) 摘要:为了精准获取网页主题,网络爬虫通常使用各种Web信息链接a鄄gesye值。论文中,为了Webcrawlersaccuracy predictinglinkagesvalue,提出了一种Web搜索策略,可以根据爬取的网页自动调整各种Web信息。爬虫具有学习能力,可以通过爬取训练集分析Web信息,以及Web信息,得到更好的搜索策略对应的实际Web。传统 Web 信息组合算法实验结果表明,基于 Webcrawler 的固定权重 Web 信息,新的爬虫具有更高的搜索精度。关键词:网络爬虫;链接价值;话题搜索;搜索策略;网络信息组合虽然互联网上有很多优秀的搜索引擎,如Google、Yahoo、AltaVista等,但由于信息量的不断增长和快速更新,常见搜索引擎的信息覆盖率不断下降,即使在目前全球最大的搜索引擎谷歌中,也只索引了全部网页的 40%。关键词:网络爬虫;链接价值;话题搜索;搜索策略;网络信息组合虽然互联网上有很多优秀的搜索引擎,如Google、Yahoo、AltaVista等,但由于信息量的不断增长和快速更新,常见搜索引擎的信息覆盖率不断下降,即使在目前全球最大的搜索引擎谷歌中,也只索引了全部网页的 40%。关键词:网络爬虫;链接价值;话题搜索;搜索策略;网络信息组合虽然互联网上有很多优秀的搜索引擎,如Google、Yahoo、AltaVista等,但由于信息量的不断增长和快速更新,常见搜索引擎的信息覆盖率不断下降,即使在目前全球最大的搜索引擎谷歌中,也只索引了全部网页的 40%。

此外,传统的信息检索方式已经不能满足特定人群对特定信息的需求。专业的搜索引擎是目前解决上述问题的较好方式,其出现也是一种技术趋势。它只搜索某个主题,并提供有关该主题的更全面和准确的信息。它对网络蜘蛛的搜索效率提出了更高的要求,要求它有选择地搜索那些与预定义主题相关的页面。在专业的搜索引擎中,Web采集器的任务是确定链接的访问顺序,获取网页。采集 的专业主题页面在遍历 Web 时尽可能多地引用 采集 和已建立的主题。虽然现有的网页排序方法有很多,它们可以概括为两类:基于文本内容的和基于Web链接结构的。为了更准确地预测待采集页面的主题相关性,利用各种Web信息来判断搜索方向。现有搜索算法中最常用的网页信息有页面URL、父页面信息、兄弟链接信息和链接文本信息。以上四类网页信息可以独立用于Web采集的搜索算法和网页的排名算法中,可以结合起来更准确地预测链接主题的相关性。目前现有的采集算法通常在采集时根据固定的权重确定这四种信息的组合,但实际上,

因此,Web 信息的组合应该能够根据 Web 资源的实际情况动态调整,以达到更好的符合 Web 实际情况的搜索策略,并具有一定的自学习性。基于以上分析,本文提出了一种可以自学习Web信息组合的Web采集策略。这个策略可以根据采集预爬的实际结果和预期结果的差异进行调整。各类Web信息的判断权重。实验结果表明,新算法比固定权重的组合算法具有更高的搜索效率。现有信息组合算法概述 Web采集器 的任务是确定访问链接的顺序并获取网页,通常从一个“初始种子集”开始,以迭代的方式访问页面并提取上面的链接采集在@>过程中,未访问的链接被临时存储在一个称为“搜索前沿”的队列中。采集器 根据搜索前沿中链接的“重要性”,确定下一个要访问的链接。Web采集器未访问链接的重要性只能根据已经采集的信息来预测。目前,常用来预测链接值的Web信息有:父页面信息、链接文本信息、页面URL信息和兄弟链接信息。页面的URL信息。有时可以从页面的 URL 地址大致推断出页面的主题。例如:

2)通常情况下,如果父页面的文本内容与要搜索的主题高度相似,那么父页面的外链页面也可能与主题更相关。兄弟链接信息。同一父页面上的链接称为兄弟链接。根据信息的局部聚类,通常物理距离越近的页面在主题[6-7]中的相关性越强,因此可以在同一页面上的兄弟链接之间提供主题参考信息。如果一个页面有更多与主题相关的兄弟页面,它可能与主题本身更相关。4)链接文本信息。通常,如果链接或链接周围的文本信息与主题高度相关,则链接所指向的页面更有可能与主题相关。国内外学者对如何利用Web信息来指导Web的采集过程进行了大量研究采集器:通常使用最多的是父页面的文本信息和链接文本信息。主要根据主题信息(如:关键词,主题相关文档)与网页或链接文本的“语义相似度”来判断链接值的高低,相似度越高给定更高的链接。查鲁 C. Aggarwa提出了一种基于信息熵的Web采集方法,给定某个页面的各种Web信息[8-9],计算该页面属于主题的概率的信息增益,然后这些信息增益值根据固定权重进行加权求和,

参考文献[6]结合了几种Web信息,通过计算简单的加权和来预测链接值。链接的综合价值是通过父页面信息、链接文本信息、链接URL信息、兄弟链接信息来预测的。相关性只是简单地加权,越重要的信息对应的权重越大。信息组合模式的自适应改进 根据对Web信息资源的分析,Web资源的组织形式是多种多样的,不同主题资源的组织形式往往差异很大[10-11]一些URL标志包括获取更多主题信息,并且一些父子页面的主题相关性非常接近。因此,上述算法都有一个共同的不足,即采集器 无法根据Web资源的实际组织情况自动调整每条信息的预测重要性,缺乏自学习能力。在本文中,为了使采集器在调整Web信息的重要性方面进行自学习,在主题采集之前,采集器使用一小部分种子集进行训练,根据预爬的方法。修正采集中页面实际相关度与根据每条Web信息预测的相关度的差异,修正每条Web信息的判断权重,最终得到符合主题和实际的合适权重万维网的情况。本文选取了四种常见的Web信息:父页面信息、链接文本信息、链接URL信息、和兄弟链接信息共同处理采集页面预测和主题之间的相关性。公式如下: 其中,I(p )为链接p的综合值,反映了链接所指向的页面与主题的可能相关性;I表示根据链接文本信息、兄弟链接信息、父页面信息、链接URL信息预测的链接为实数,表示加权,反映了各个Web信息对判断链接值的重要性,越多重要信息对应较大的权重。它反映了链接所指向的页面和主题的可能相关性;I表示根据链接文本信息、兄弟链接信息、父页面信息、链接URL信息预测的链接为实数,表示加权,反映了各个Web信息对判断链接值的重要性,越多重要信息对应较大的权重。它反映了链接所指向的页面和主题的可能相关性;I表示根据链接文本信息、兄弟链接信息、父页面信息、链接URL信息预测的链接为实数,表示加权,反映了各个Web信息对判断链接值的重要性,越多重要信息对应较大的权重。

现有算法是根据统计数据在采集之前人为设置的,不会随着主题和页面集的不同而变化,难以适应所有的搜索条件。为了使 采集器 能够为实际的 采集 任务选择合适的权重,在进入页面 采集 之前,会选择一小部分种子集来预训练采集器。训练开始时将四种Web信息的权重设置为相等(W Ling et al.: Research on the self-learning of information combination in Web采集, Web information预测页面的相关性为 采集 ,这保证了训练过程中的无偏权重设置。对于搜索前沿队列中每个待处理的 采集 链接 p,根据已知的链接文本信息、兄弟链接信息、父页面信息、链接URL信息来预测该链接所指向的页面与主题的相关性,称为预测相关性。表示I所指向的页面后,计算该页面与主题的实际相关度,记为R(p)。这样,根据每类信息得到的实际相关性和预测相关性之间存在差异,可以用这种差异与实际相关性的比值来衡量预测相关性与实际相关性之间的偏差。记为偏差值f,计算方法见公式(2)。偏差值越小,基于此类Web信息预测的链接值越准确。在实际采集中,可以适当增加这个Web信息的重要性,就是在公式(1).

users基于固定权重的web信息的加权和与本文讨论的web信息结合自学习采集users来比较采集的性能。实验的主题是关于人工智能的采集 论文。页面与本词典之间的文本相似度用于评估与主题的相关性。

向量空间模型用于表示网页,页面的相似度采用向量间夹角的余弦公式。实验中,使用搜索准确度来评价该算法的采集性能,计算如下: 搜索准确度=结果集中相关文档数占结果总文档数设置为固定权重的采集,使用统计数据设置权重,对于权重自学习采集的人,仔细选择网站关于人工智能的一部分作为种子集训练它,获取权重,然后让它执行 采集 任务。具有自学习权重的采集用户访问的页面数和采集访问的页面数 计算了固定权重的用户和采集的AI相关网页的数量,并计算了他们的搜索准确率。,进行对比(见图1)。可以看出,由于权重自学习Web采集通过训练集的学习优化了Web信息的组合权重,在采集采集任务在搜索准确率上明显比固定权重的Web采集用户有优势,比如当50%的页面被访问时,权重自学习的Web采集搜索准确率比基于固定加权和算法的Web采集提高12%左右,错误率更小,可以更灵活地针对实际Web资源情况进行自我调整。分析了主题爬取算法。

该算法进一步考虑了网页的链接结构和主题内容,大大提高了信息采集的召回率,同时也过滤掉了大量的噪声链接,提高了搜索效率。在接下来的工作中,我们将继续挖掘网页中收录的主题信息,结合可以代表网页链接结构的PageRank值,进一步提高算法的性能。参考文献:搜索引擎与网络挖掘进展[M].北京:高等教育出版社,2003:34-40. AggarwalC,AI -Garawi F,Yu Intelligentcrawling Worldwide web 任意谓词[第十届国际万维网会议。香港:[s。专业搜索引擎的排序算法研究[J].现代图书馆与信息技术,2006(7):20-2< @4. 主题爬虫的设计与实现[J]. 计算机应用, 2004, 24(06Z): 270-272. 支持Web信息分类的高性能蜘蛛程序[J]. 小型微机系统, 2006, 27(7):1308- 1312.@ > ChakrabartiS,van den Berg M,Dom Distributedhyper鄄text resource discovery through examples[C] VLDBconference. Edinburgh,Scotland:[s. Accelerated评价算法:一种提高网页结构挖掘质量的新方法[J].计算机研究与发展,2004,41(1):98-103.网页识别中的特征选择研究[J]. J].计算机工程,2000,26(8):35-37. 支持Web信息分类的高性能蜘蛛程序[J]. 小型微机系统, 2006, 27(7):1308- 1312.@ > ChakrabartiS,van den Berg M,Dom Distributedhyper鄄text resource discovery through examples[C] VLDBconference. Edinburgh,Scotland:[s. Accelerated评价算法:一种提高网页结构挖掘质量的新方法[J].计算机研究与发展,2004,41(1):98-103.网页识别中的特征选择研究[J]. J].计算机工程,2000,26(8):35-37. 支持Web信息分类的高性能蜘蛛程序[J]. 小型微机系统, 2006, 27(7):1308- 1312.@ > ChakrabartiS,van den Berg M,Dom Distributedhyper鄄text resource discovery through examples[C] VLDBconference. Edinburgh,Scotland:[s. Accelerated评价算法:一种提高网页结构挖掘质量的新方法[J].计算机研究与发展,2004,41(1):98-103.网页识别中的特征选择研究[J]. J].计算机工程,2000,26(8):35-37. 一种提高Web结构挖掘质量的新途径[J].计算机研究与发展,2004,41(1):98-103.网页识别中的特征选择研究[J].计算机工程,2000,26(8):35- 37. 一种提高Web结构挖掘质量的新途径[J].计算机研究与发展,2004,41(1):98-103.网页识别中的特征选择研究[J].计算机工程,2000,26(8):35- 37. 查看全部

采集自动组合(预测链接价值的Web信息固定组合的算法进行了比较)

为了提高Web采集系统预测链接值的准确性,提出了一种方法。一个可以根据现有的采集页面调整Web信息重要性的Web。它具有学习能力,可以通过对训练集的爬取,分析各种Web信息对预测链接值的重要性,从而调整采集过程中,得到各个Web信息的组合权重,得到更好的符合Web实际情况的搜索策略。以计算机为采集的主体,将该算法与传统的Web信息固定组合算法进行了比较。实验结果表明,与传统的Web采集用户相比,使用该算法的采集用户具有更高的Web搜索准确率。关键词:Web 采集 用户;链接值;主题搜索;搜索策略;Web 信息组合 CCL:TP391 Shake文章 代码:1673-629X(2013)11-0216-03doi:10. 3969 issn.1673 - 629X. 2013. 11. 053 Research InformationCombination WebCollecting 张玲,徐亮,蒋华(湖南第一师范学院信息科学系,长沙410205) 摘要:为了精准获取网页主题,网络爬虫通常使用各种Web信息链接a鄄gesye值。论文中,为了Webcrawlersaccuracy predictinglinkagesvalue,提出了一种Web搜索策略,可以根据爬取的网页自动调整各种Web信息。爬虫具有学习能力,可以通过爬取训练集分析Web信息,以及Web信息,得到更好的搜索策略对应的实际Web。传统 Web 信息组合算法实验结果表明,基于 Webcrawler 的固定权重 Web 信息,新的爬虫具有更高的搜索精度。关键词:网络爬虫;链接价值;话题搜索;搜索策略;网络信息组合虽然互联网上有很多优秀的搜索引擎,如Google、Yahoo、AltaVista等,但由于信息量的不断增长和快速更新,常见搜索引擎的信息覆盖率不断下降,即使在目前全球最大的搜索引擎谷歌中,也只索引了全部网页的 40%。关键词:网络爬虫;链接价值;话题搜索;搜索策略;网络信息组合虽然互联网上有很多优秀的搜索引擎,如Google、Yahoo、AltaVista等,但由于信息量的不断增长和快速更新,常见搜索引擎的信息覆盖率不断下降,即使在目前全球最大的搜索引擎谷歌中,也只索引了全部网页的 40%。关键词:网络爬虫;链接价值;话题搜索;搜索策略;网络信息组合虽然互联网上有很多优秀的搜索引擎,如Google、Yahoo、AltaVista等,但由于信息量的不断增长和快速更新,常见搜索引擎的信息覆盖率不断下降,即使在目前全球最大的搜索引擎谷歌中,也只索引了全部网页的 40%。

此外,传统的信息检索方式已经不能满足特定人群对特定信息的需求。专业的搜索引擎是目前解决上述问题的较好方式,其出现也是一种技术趋势。它只搜索某个主题,并提供有关该主题的更全面和准确的信息。它对网络蜘蛛的搜索效率提出了更高的要求,要求它有选择地搜索那些与预定义主题相关的页面。在专业的搜索引擎中,Web采集器的任务是确定链接的访问顺序,获取网页。采集 的专业主题页面在遍历 Web 时尽可能多地引用 采集 和已建立的主题。虽然现有的网页排序方法有很多,它们可以概括为两类:基于文本内容的和基于Web链接结构的。为了更准确地预测待采集页面的主题相关性,利用各种Web信息来判断搜索方向。现有搜索算法中最常用的网页信息有页面URL、父页面信息、兄弟链接信息和链接文本信息。以上四类网页信息可以独立用于Web采集的搜索算法和网页的排名算法中,可以结合起来更准确地预测链接主题的相关性。目前现有的采集算法通常在采集时根据固定的权重确定这四种信息的组合,但实际上,

因此,Web 信息的组合应该能够根据 Web 资源的实际情况动态调整,以达到更好的符合 Web 实际情况的搜索策略,并具有一定的自学习性。基于以上分析,本文提出了一种可以自学习Web信息组合的Web采集策略。这个策略可以根据采集预爬的实际结果和预期结果的差异进行调整。各类Web信息的判断权重。实验结果表明,新算法比固定权重的组合算法具有更高的搜索效率。现有信息组合算法概述 Web采集器 的任务是确定访问链接的顺序并获取网页,通常从一个“初始种子集”开始,以迭代的方式访问页面并提取上面的链接采集在@>过程中,未访问的链接被临时存储在一个称为“搜索前沿”的队列中。采集器 根据搜索前沿中链接的“重要性”,确定下一个要访问的链接。Web采集器未访问链接的重要性只能根据已经采集的信息来预测。目前,常用来预测链接值的Web信息有:父页面信息、链接文本信息、页面URL信息和兄弟链接信息。页面的URL信息。有时可以从页面的 URL 地址大致推断出页面的主题。例如:

2)通常情况下,如果父页面的文本内容与要搜索的主题高度相似,那么父页面的外链页面也可能与主题更相关。兄弟链接信息。同一父页面上的链接称为兄弟链接。根据信息的局部聚类,通常物理距离越近的页面在主题[6-7]中的相关性越强,因此可以在同一页面上的兄弟链接之间提供主题参考信息。如果一个页面有更多与主题相关的兄弟页面,它可能与主题本身更相关。4)链接文本信息。通常,如果链接或链接周围的文本信息与主题高度相关,则链接所指向的页面更有可能与主题相关。国内外学者对如何利用Web信息来指导Web的采集过程进行了大量研究采集器:通常使用最多的是父页面的文本信息和链接文本信息。主要根据主题信息(如:关键词,主题相关文档)与网页或链接文本的“语义相似度”来判断链接值的高低,相似度越高给定更高的链接。查鲁 C. Aggarwa提出了一种基于信息熵的Web采集方法,给定某个页面的各种Web信息[8-9],计算该页面属于主题的概率的信息增益,然后这些信息增益值根据固定权重进行加权求和,

参考文献[6]结合了几种Web信息,通过计算简单的加权和来预测链接值。链接的综合价值是通过父页面信息、链接文本信息、链接URL信息、兄弟链接信息来预测的。相关性只是简单地加权,越重要的信息对应的权重越大。信息组合模式的自适应改进 根据对Web信息资源的分析,Web资源的组织形式是多种多样的,不同主题资源的组织形式往往差异很大[10-11]一些URL标志包括获取更多主题信息,并且一些父子页面的主题相关性非常接近。因此,上述算法都有一个共同的不足,即采集器 无法根据Web资源的实际组织情况自动调整每条信息的预测重要性,缺乏自学习能力。在本文中,为了使采集器在调整Web信息的重要性方面进行自学习,在主题采集之前,采集器使用一小部分种子集进行训练,根据预爬的方法。修正采集中页面实际相关度与根据每条Web信息预测的相关度的差异,修正每条Web信息的判断权重,最终得到符合主题和实际的合适权重万维网的情况。本文选取了四种常见的Web信息:父页面信息、链接文本信息、链接URL信息、和兄弟链接信息共同处理采集页面预测和主题之间的相关性。公式如下: 其中,I(p )为链接p的综合值,反映了链接所指向的页面与主题的可能相关性;I表示根据链接文本信息、兄弟链接信息、父页面信息、链接URL信息预测的链接为实数,表示加权,反映了各个Web信息对判断链接值的重要性,越多重要信息对应较大的权重。它反映了链接所指向的页面和主题的可能相关性;I表示根据链接文本信息、兄弟链接信息、父页面信息、链接URL信息预测的链接为实数,表示加权,反映了各个Web信息对判断链接值的重要性,越多重要信息对应较大的权重。它反映了链接所指向的页面和主题的可能相关性;I表示根据链接文本信息、兄弟链接信息、父页面信息、链接URL信息预测的链接为实数,表示加权,反映了各个Web信息对判断链接值的重要性,越多重要信息对应较大的权重。

现有算法是根据统计数据在采集之前人为设置的,不会随着主题和页面集的不同而变化,难以适应所有的搜索条件。为了使 采集器 能够为实际的 采集 任务选择合适的权重,在进入页面 采集 之前,会选择一小部分种子集来预训练采集器。训练开始时将四种Web信息的权重设置为相等(W Ling et al.: Research on the self-learning of information combination in Web采集, Web information预测页面的相关性为 采集 ,这保证了训练过程中的无偏权重设置。对于搜索前沿队列中每个待处理的 采集 链接 p,根据已知的链接文本信息、兄弟链接信息、父页面信息、链接URL信息来预测该链接所指向的页面与主题的相关性,称为预测相关性。表示I所指向的页面后,计算该页面与主题的实际相关度,记为R(p)。这样,根据每类信息得到的实际相关性和预测相关性之间存在差异,可以用这种差异与实际相关性的比值来衡量预测相关性与实际相关性之间的偏差。记为偏差值f,计算方法见公式(2)。偏差值越小,基于此类Web信息预测的链接值越准确。在实际采集中,可以适当增加这个Web信息的重要性,就是在公式(1).

users基于固定权重的web信息的加权和与本文讨论的web信息结合自学习采集users来比较采集的性能。实验的主题是关于人工智能的采集 论文。页面与本词典之间的文本相似度用于评估与主题的相关性。

向量空间模型用于表示网页,页面的相似度采用向量间夹角的余弦公式。实验中,使用搜索准确度来评价该算法的采集性能,计算如下: 搜索准确度=结果集中相关文档数占结果总文档数设置为固定权重的采集,使用统计数据设置权重,对于权重自学习采集的人,仔细选择网站关于人工智能的一部分作为种子集训练它,获取权重,然后让它执行 采集 任务。具有自学习权重的采集用户访问的页面数和采集访问的页面数 计算了固定权重的用户和采集的AI相关网页的数量,并计算了他们的搜索准确率。,进行对比(见图1)。可以看出,由于权重自学习Web采集通过训练集的学习优化了Web信息的组合权重,在采集采集任务在搜索准确率上明显比固定权重的Web采集用户有优势,比如当50%的页面被访问时,权重自学习的Web采集搜索准确率比基于固定加权和算法的Web采集提高12%左右,错误率更小,可以更灵活地针对实际Web资源情况进行自我调整。分析了主题爬取算法。

该算法进一步考虑了网页的链接结构和主题内容,大大提高了信息采集的召回率,同时也过滤掉了大量的噪声链接,提高了搜索效率。在接下来的工作中,我们将继续挖掘网页中收录的主题信息,结合可以代表网页链接结构的PageRank值,进一步提高算法的性能。参考文献:搜索引擎与网络挖掘进展[M].北京:高等教育出版社,2003:34-40. AggarwalC,AI -Garawi F,Yu Intelligentcrawling Worldwide web 任意谓词[第十届国际万维网会议。香港:[s。专业搜索引擎的排序算法研究[J].现代图书馆与信息技术,2006(7):20-2< @4. 主题爬虫的设计与实现[J]. 计算机应用, 2004, 24(06Z): 270-272. 支持Web信息分类的高性能蜘蛛程序[J]. 小型微机系统, 2006, 27(7):1308- 1312.@ > ChakrabartiS,van den Berg M,Dom Distributedhyper鄄text resource discovery through examples[C] VLDBconference. Edinburgh,Scotland:[s. Accelerated评价算法:一种提高网页结构挖掘质量的新方法[J].计算机研究与发展,2004,41(1):98-103.网页识别中的特征选择研究[J]. J].计算机工程,2000,26(8):35-37. 支持Web信息分类的高性能蜘蛛程序[J]. 小型微机系统, 2006, 27(7):1308- 1312.@ > ChakrabartiS,van den Berg M,Dom Distributedhyper鄄text resource discovery through examples[C] VLDBconference. Edinburgh,Scotland:[s. Accelerated评价算法:一种提高网页结构挖掘质量的新方法[J].计算机研究与发展,2004,41(1):98-103.网页识别中的特征选择研究[J]. J].计算机工程,2000,26(8):35-37. 支持Web信息分类的高性能蜘蛛程序[J]. 小型微机系统, 2006, 27(7):1308- 1312.@ > ChakrabartiS,van den Berg M,Dom Distributedhyper鄄text resource discovery through examples[C] VLDBconference. Edinburgh,Scotland:[s. Accelerated评价算法:一种提高网页结构挖掘质量的新方法[J].计算机研究与发展,2004,41(1):98-103.网页识别中的特征选择研究[J]. J].计算机工程,2000,26(8):35-37. 一种提高Web结构挖掘质量的新途径[J].计算机研究与发展,2004,41(1):98-103.网页识别中的特征选择研究[J].计算机工程,2000,26(8):35- 37. 一种提高Web结构挖掘质量的新途径[J].计算机研究与发展,2004,41(1):98-103.网页识别中的特征选择研究[J].计算机工程,2000,26(8):35- 37.

采集自动组合(可视化操作操作简单,完全可视化,专业it人员.自定义)

采集交流 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-03-15 17:16

vg浏览器是一款带有采集功能的营销浏览器,支持可视化脚本,可以设置脚本、自动登录、自动识别验证、自动运行、自动抓取网页数据等功能。

特征

可视化操作

操作简单,图形操作全可视化,无需专业IT人员。

定制流程

采集就像积木一样,功能可以自由组合。

自动编码

程序注重采集效率,页面解析速度快。

生成exe

自动登录,自动识别验证码,是一款万能浏览器。

指示

通过css path定位网页元素的路径是vg浏览器一个非常实用的功能。选择任何需要填写css路径规则的步骤,点击内置浏览器的按钮。

点击一个网页元素,自动生成该元素的css路径。极少数框架复杂的网页可能无法通过内置浏览器生成路径。您也可以在其他浏览器上复制 css 路径。目前,各种多核浏览器都支持复制css路径。比如谷歌浏览器、360安全浏览器、360极速浏览器、UC浏览器等chrome核心浏览器可以按F12键,或者在页面上右键,选择inspect元素,

右键单击目标节点并选择复制 css 路径,将 css 路径复制到剪贴板。

火狐浏览器也可以按f12或者右键查看元素。显示开发者工具后,右击底部节点,选择“复制唯一选择器”,复制css路径。

CSS 路径规则与 jquery 选择器规则完全兼容。如果你知道如何编写 jquery 选择器,你也可以自己编写 CSS 路径。 查看全部

采集自动组合(可视化操作操作简单,完全可视化,专业it人员.自定义)

vg浏览器是一款带有采集功能的营销浏览器,支持可视化脚本,可以设置脚本、自动登录、自动识别验证、自动运行、自动抓取网页数据等功能。

特征

可视化操作

操作简单,图形操作全可视化,无需专业IT人员。

定制流程

采集就像积木一样,功能可以自由组合。

自动编码

程序注重采集效率,页面解析速度快。

生成exe

自动登录,自动识别验证码,是一款万能浏览器。

指示

通过css path定位网页元素的路径是vg浏览器一个非常实用的功能。选择任何需要填写css路径规则的步骤,点击内置浏览器的按钮。

点击一个网页元素,自动生成该元素的css路径。极少数框架复杂的网页可能无法通过内置浏览器生成路径。您也可以在其他浏览器上复制 css 路径。目前,各种多核浏览器都支持复制css路径。比如谷歌浏览器、360安全浏览器、360极速浏览器、UC浏览器等chrome核心浏览器可以按F12键,或者在页面上右键,选择inspect元素,

右键单击目标节点并选择复制 css 路径,将 css 路径复制到剪贴板。

火狐浏览器也可以按f12或者右键查看元素。显示开发者工具后,右击底部节点,选择“复制唯一选择器”,复制css路径。

CSS 路径规则与 jquery 选择器规则完全兼容。如果你知道如何编写 jquery 选择器,你也可以自己编写 CSS 路径。

采集自动组合(采集自动组合高曝光摄像头曝光合适之后可以组合成)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-03-09 07:04

采集自动组合高曝光摄像头曝光合适之后可以组合成全自动合成3d视频云台云台可以旋转之后可以组合成全自动三维合成视频。通过摄像头可以录制内容到编辑卡槽再合成视频,一定程度上可以做到更好地脱手拍摄。

机位加机位导致非常多的组合动作,这些动作非常复杂,作为一个小团队分析完可能就是一天的时间,所以现在普遍都是用数据线传输。

不可以三维摄像头就是一次性高利用,你把这个花在一件事上面意义就不大,而且要是四个以上,价格也比较昂贵不过你想跟踪肯定可以的吧,没有任何不可以做3d摄像头的厂家都想把机器卖给你但是他们不会出售,都是跟高校合作的大学有一节专门的公开课叫《3d影像处理设备》就是教你怎么用电脑做3d影像处理给你打个广告,如果有兴趣可以听听电脑三维模型建立图像跟踪技术培训。

综合教育学院张志青院长的研究方向是3d影像处理,现在也比较热。老一代搞3d的大多是搞仿真的,搞工程的主要是用于教学用途。随着科技发展,以后综合教育学院的3d影像处理方向肯定还会有一些发展。你从基础到专业不可能一步到位,而是一级一级,循序渐进的,他们都会愿意跟新的学科主题来设置课程,这样他们的数据库就有了,就能找到素材来推出3d摄像头产品了。 查看全部

采集自动组合(采集自动组合高曝光摄像头曝光合适之后可以组合成)

采集自动组合高曝光摄像头曝光合适之后可以组合成全自动合成3d视频云台云台可以旋转之后可以组合成全自动三维合成视频。通过摄像头可以录制内容到编辑卡槽再合成视频,一定程度上可以做到更好地脱手拍摄。

机位加机位导致非常多的组合动作,这些动作非常复杂,作为一个小团队分析完可能就是一天的时间,所以现在普遍都是用数据线传输。

不可以三维摄像头就是一次性高利用,你把这个花在一件事上面意义就不大,而且要是四个以上,价格也比较昂贵不过你想跟踪肯定可以的吧,没有任何不可以做3d摄像头的厂家都想把机器卖给你但是他们不会出售,都是跟高校合作的大学有一节专门的公开课叫《3d影像处理设备》就是教你怎么用电脑做3d影像处理给你打个广告,如果有兴趣可以听听电脑三维模型建立图像跟踪技术培训。

综合教育学院张志青院长的研究方向是3d影像处理,现在也比较热。老一代搞3d的大多是搞仿真的,搞工程的主要是用于教学用途。随着科技发展,以后综合教育学院的3d影像处理方向肯定还会有一些发展。你从基础到专业不可能一步到位,而是一级一级,循序渐进的,他们都会愿意跟新的学科主题来设置课程,这样他们的数据库就有了,就能找到素材来推出3d摄像头产品了。

采集自动组合(网站能采集吗?采集站怎么做?网站怎么采集?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-03-08 02:10

网站采集是大部分站长都离不开的话题,网站你能采集吗? 网站采集怎么样? 采集怎么办?这些都是站长们非常关心的问题。今天跟大家聊聊网站采集,小编在这方面还是有一些研究的,网站采集绝对可以做到,而且现在大部分网站全部使用采集,关键是采集的内容处理,以及采集的数据源的选择,很好的解决这些问题,哪怕是纯采集 站。快收录,提升你的排名。

网站采集的所有采集功能都是免费的,并提供开源发布接口。它可以爬取单页和多页,并且可以爬取指定URL的内容。然后使用多线程爬取,多任务多线程快速爬取,提高采集的速度。这启用了批处理采集,无论是列表采集、内容采集、内容发布分步,还是组合批处理采集。

网站采集的数据文章内容存储在Mysql数据库中。广泛使用的Mysql数据库存储将更加轻量和高效。包括图片附件的下载和保存,网站采集可以同时保存远程图片定位。加上附件上传,这允许图像附件自动上传到网站。 网站采集,使用通用的网站接口,无论是WordPresscms还是织梦cms,Empirecms等开源程序无缝兼容。

网站采集同时还具有自动缩略图功能,从内容页面中提取第一页图片作为缩略图,使 节点。 采集节点收到爬虫任务后,从资源池中获取相应的系统资源并立即发起请求,将相应的数据发送给目标网站采集,同时启动数据cleaner,并根据相应的数据清洗规则对数据进行清洗。

网站采集完成数据采集后,将对应的结果返回给服务器。为了保证数据能够以最快的速度采集,系统会将采集任务推送到各个算子的采集网络节点,同步发起网络请求。保证可以一直使用最优的网络节点,对应的数据能以最快的速度采集。

网站采集的文章分享就写到这里,希望对广大站长有所帮助。 网站采集并不是唯一的建站方式,而是更方便快捷的方式。单独采集,网站肯定起不来,必须结合SEO优化对网站整体进行优化,才能达到优化效果。返回搜狐,查看更多 查看全部

采集自动组合(网站能采集吗?采集站怎么做?网站怎么采集?)

网站采集是大部分站长都离不开的话题,网站你能采集吗? 网站采集怎么样? 采集怎么办?这些都是站长们非常关心的问题。今天跟大家聊聊网站采集,小编在这方面还是有一些研究的,网站采集绝对可以做到,而且现在大部分网站全部使用采集,关键是采集的内容处理,以及采集的数据源的选择,很好的解决这些问题,哪怕是纯采集 站。快收录,提升你的排名。

网站采集的所有采集功能都是免费的,并提供开源发布接口。它可以爬取单页和多页,并且可以爬取指定URL的内容。然后使用多线程爬取,多任务多线程快速爬取,提高采集的速度。这启用了批处理采集,无论是列表采集、内容采集、内容发布分步,还是组合批处理采集。

网站采集的数据文章内容存储在Mysql数据库中。广泛使用的Mysql数据库存储将更加轻量和高效。包括图片附件的下载和保存,网站采集可以同时保存远程图片定位。加上附件上传,这允许图像附件自动上传到网站。 网站采集,使用通用的网站接口,无论是WordPresscms还是织梦cms,Empirecms等开源程序无缝兼容。

网站采集同时还具有自动缩略图功能,从内容页面中提取第一页图片作为缩略图,使 节点。 采集节点收到爬虫任务后,从资源池中获取相应的系统资源并立即发起请求,将相应的数据发送给目标网站采集,同时启动数据cleaner,并根据相应的数据清洗规则对数据进行清洗。

网站采集完成数据采集后,将对应的结果返回给服务器。为了保证数据能够以最快的速度采集,系统会将采集任务推送到各个算子的采集网络节点,同步发起网络请求。保证可以一直使用最优的网络节点,对应的数据能以最快的速度采集。

网站采集的文章分享就写到这里,希望对广大站长有所帮助。 网站采集并不是唯一的建站方式,而是更方便快捷的方式。单独采集,网站肯定起不来,必须结合SEO优化对网站整体进行优化,才能达到优化效果。返回搜狐,查看更多

采集拼多多评价中的晒图链接并下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 330 次浏览 • 2022-05-21 06:25

访问电商记网站()安装浏览器插件v9.1.4以上版本即可使用本功能。

流程一开始,用户输入一个拼多多商品ID。流程会打开一个拼多多商品评价页面,点击“图/视频”选项。

然后自动往下滚动页面。

在评价页面滚动过程中,浏览器从网站获得评价数据,这些数据被解析为表格。当流程结束运行后,自动保存为Excel文件。

采集结果包含5列或更多,第一列是评价内容,第二列是SKU名称,第三列是SKU的值,第四列是日期,第五列或更多是图片。

在采集评价过程中,下载所有图片链接,如图示底部。

查看全部

采集拼多多评价中的晒图链接并下载

访问电商记网站()安装浏览器插件v9.1.4以上版本即可使用本功能。

流程一开始,用户输入一个拼多多商品ID。流程会打开一个拼多多商品评价页面,点击“图/视频”选项。

然后自动往下滚动页面。

在评价页面滚动过程中,浏览器从网站获得评价数据,这些数据被解析为表格。当流程结束运行后,自动保存为Excel文件。

采集结果包含5列或更多,第一列是评价内容,第二列是SKU名称,第三列是SKU的值,第四列是日期,第五列或更多是图片。

在采集评价过程中,下载所有图片链接,如图示底部。

采集自动组合|“开放背后的密码”:miguelgiulia创业型的应用hadoop应用合集

采集交流 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-05-08 18:01

采集自动组合|“开放背后的密码”:miguelgiulia创业型的应用hadoop应用合集在往期的内容中,我们分享了linux命令、命令行与shell语言以及阿里云lamp系列学习,对于linux命令的学习有着较高的要求。同时,还会在后续分享linux系统编程、应用编程及python,此外还会分享各大云公司在开源云平台上所积累的最新成果,助力每个云用户成为最懂云的网络管理专家。

今天,我们继续分享最新的python及linux系统编程类内容。有个捷径,学会python基础语法以后,将其应用到linux系统编程的层面,再熟练使用实际的编程环境,很快就能学会并掌握一个新的应用开发语言。那就是python。python开发用于web的爬虫爬虫入门快,有深度,好就业。一个入门以后可以迅速在网站上生成一个爬虫,与百度等的爬虫一样,用户可以把自己在网站上获取的数据,制作成简单的自定义爬虫,然后大胆的放出来。

用户反馈数据真实、方便、效率高,商业价值大。抓取百度一级内容:一级页数:tweet(sina),qq(sina),有道(yahoo),推特(twitter)百度二级:时间:11:42:05,php(大约6秒),python(2分钟),java(1分钟),ruby(大约20秒)、豆瓣网(大约70秒)三级网站在php之外,加上twitter的返回页面,算是二级网站(php和java的共同)。

python和java的成本比较低,入门的时候确实是一个很好的选择。企业的网站,存在同一个内容分布,需要一级和二级,采集次数比较多的话,就会涉及到多个网站,可以实现。爬虫和java开发的数据比较像,因此这两者很容易重合。开发二级网站:一个页面:reddit(国外最大的)的返回页面:url中的serverurl请求地址,hostnamecachekeyuserfile.jpg目标网站:登录:域名/,你甚至可以自己写一个,爬取登录接口。

并且每个页面上都会有token,不能让爬虫登录页面时,跳过不应该爬取的token。再hostnamespace值是php路径(../,该页面的token返回给你,比如/seo,/index.php等,该页面的token就是/seo../。一个页面上有多个网站可能并不是问题,每个页面带多个token的情况下,通过reddit自己,再通过三级转发的方式就能到每个页面。

在爬取一个二级网站前,需要找到该页面所有的token对应的对应的,在python或java中都有实现方法。爬取百度一级页面:访问cookie,我们采用cookie来记录:一个cookie:访问百度timestamp:创建一个cookie的时间戳flush_cookie:将cookie刷新到指定的浏览器send_http请求:创建发送网络请求对。 查看全部

采集自动组合|“开放背后的密码”:miguelgiulia创业型的应用hadoop应用合集

采集自动组合|“开放背后的密码”:miguelgiulia创业型的应用hadoop应用合集在往期的内容中,我们分享了linux命令、命令行与shell语言以及阿里云lamp系列学习,对于linux命令的学习有着较高的要求。同时,还会在后续分享linux系统编程、应用编程及python,此外还会分享各大云公司在开源云平台上所积累的最新成果,助力每个云用户成为最懂云的网络管理专家。

今天,我们继续分享最新的python及linux系统编程类内容。有个捷径,学会python基础语法以后,将其应用到linux系统编程的层面,再熟练使用实际的编程环境,很快就能学会并掌握一个新的应用开发语言。那就是python。python开发用于web的爬虫爬虫入门快,有深度,好就业。一个入门以后可以迅速在网站上生成一个爬虫,与百度等的爬虫一样,用户可以把自己在网站上获取的数据,制作成简单的自定义爬虫,然后大胆的放出来。

用户反馈数据真实、方便、效率高,商业价值大。抓取百度一级内容:一级页数:tweet(sina),qq(sina),有道(yahoo),推特(twitter)百度二级:时间:11:42:05,php(大约6秒),python(2分钟),java(1分钟),ruby(大约20秒)、豆瓣网(大约70秒)三级网站在php之外,加上twitter的返回页面,算是二级网站(php和java的共同)。

python和java的成本比较低,入门的时候确实是一个很好的选择。企业的网站,存在同一个内容分布,需要一级和二级,采集次数比较多的话,就会涉及到多个网站,可以实现。爬虫和java开发的数据比较像,因此这两者很容易重合。开发二级网站:一个页面:reddit(国外最大的)的返回页面:url中的serverurl请求地址,hostnamecachekeyuserfile.jpg目标网站:登录:域名/,你甚至可以自己写一个,爬取登录接口。

并且每个页面上都会有token,不能让爬虫登录页面时,跳过不应该爬取的token。再hostnamespace值是php路径(../,该页面的token返回给你,比如/seo,/index.php等,该页面的token就是/seo../。一个页面上有多个网站可能并不是问题,每个页面带多个token的情况下,通过reddit自己,再通过三级转发的方式就能到每个页面。

在爬取一个二级网站前,需要找到该页面所有的token对应的对应的,在python或java中都有实现方法。爬取百度一级页面:访问cookie,我们采用cookie来记录:一个cookie:访问百度timestamp:创建一个cookie的时间戳flush_cookie:将cookie刷新到指定的浏览器send_http请求:创建发送网络请求对。

采集自动组合、保持两个信号间的通用法则

采集交流 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2022-05-05 23:01

采集自动组合、保持两个信号间的一致性,这是贯穿训练中心的通用法则。一直都想要开发这样一个app,但开发和运营并不是一个易事,最好的答案依然还是要在人工智能领域。在开发或者搭建前,我们应该要好好思考下这件事情和人工智能有什么关系。第一种解释可能会比较简单,那就是通过简单的接口来收集信息。再进一步展开解释,就是对用户授权给计算机所要求的收集样本特征的一套接口的封装,使得机器能够进行智能识别的过程。

如同电影《机械姬》里的电脑,能够通过直接改变物理世界中球球的运动轨迹来通知人的行动和动作,从而达到更好的运动控制的效果。但这毕竟太直接了,在我们开发app时,它已经根据获取的样本特征进行了二次处理,将它们固定下来,不能指导开发者,也不能提供任何数据给到app内使用。在这种情况下,我们必须要做的,是掌握应用的语义模型。

如同电影《机械姬》一样,或者像上文描述的世界,人与机器之间的关系并不是简单的“通过和拒绝”的逻辑关系,而是一种直接的依赖关系。语义模型能够让计算机掌握了人类知识中所有的逻辑规则、确定性特征,并让它们统一调整它们的运动结果,从而能够形成一套连贯和一致的效果。举个例子,人类在说话时,从头到尾,必须要呈现时间和空间两个方向上的关系,并且这两个方向必须有可靠的关联,才能表达清楚一段话的意思。

那么语义模型需要做的,就是确定说话方向和长度关系,确定关联关系,对两者进行编码,并输出逻辑关系和关联关系,确定语义规则,即说话顺序规则。在实际项目开发中,也是这样,基本都是反复从上到下,从左到右去进行语义模型的确定。它要做的,是从需求获取内容输入,在进行语义模型关联,形成语义规则,并将所有逻辑关系都运用在使用app上。

这里就涉及到有关语义模型的开发和使用了。选择一套合适的开发语言是首先要做的事情,确定何种语言开发的app比较适合人工智能,然后再选择开发语言的另一个重要标准,就是能否充分利用机器学习的技术。之前接触过的产品中,除了几家引入了机器学习,还有几家是接入了现有的语义模型,而且结果很成功。但语义模型相对计算机最基础和最重要的算法就差得远了,很多时候机器学习是提高app品质的基础,你只是用机器学习去做了重复的事情,自然不能保证方方面面。

两个方面,数据采集和自动组合。数据采集的流程基本是各家app都会有的,或者需要单独去做的,简单讲,大致是用户量大,数据收集量大的app,才需要做这些工作。整理好的信息用户只需要付出一定的paid成本,比如登录、注册,这样。 查看全部

采集自动组合、保持两个信号间的通用法则

采集自动组合、保持两个信号间的一致性,这是贯穿训练中心的通用法则。一直都想要开发这样一个app,但开发和运营并不是一个易事,最好的答案依然还是要在人工智能领域。在开发或者搭建前,我们应该要好好思考下这件事情和人工智能有什么关系。第一种解释可能会比较简单,那就是通过简单的接口来收集信息。再进一步展开解释,就是对用户授权给计算机所要求的收集样本特征的一套接口的封装,使得机器能够进行智能识别的过程。

如同电影《机械姬》里的电脑,能够通过直接改变物理世界中球球的运动轨迹来通知人的行动和动作,从而达到更好的运动控制的效果。但这毕竟太直接了,在我们开发app时,它已经根据获取的样本特征进行了二次处理,将它们固定下来,不能指导开发者,也不能提供任何数据给到app内使用。在这种情况下,我们必须要做的,是掌握应用的语义模型。

如同电影《机械姬》一样,或者像上文描述的世界,人与机器之间的关系并不是简单的“通过和拒绝”的逻辑关系,而是一种直接的依赖关系。语义模型能够让计算机掌握了人类知识中所有的逻辑规则、确定性特征,并让它们统一调整它们的运动结果,从而能够形成一套连贯和一致的效果。举个例子,人类在说话时,从头到尾,必须要呈现时间和空间两个方向上的关系,并且这两个方向必须有可靠的关联,才能表达清楚一段话的意思。

那么语义模型需要做的,就是确定说话方向和长度关系,确定关联关系,对两者进行编码,并输出逻辑关系和关联关系,确定语义规则,即说话顺序规则。在实际项目开发中,也是这样,基本都是反复从上到下,从左到右去进行语义模型的确定。它要做的,是从需求获取内容输入,在进行语义模型关联,形成语义规则,并将所有逻辑关系都运用在使用app上。

这里就涉及到有关语义模型的开发和使用了。选择一套合适的开发语言是首先要做的事情,确定何种语言开发的app比较适合人工智能,然后再选择开发语言的另一个重要标准,就是能否充分利用机器学习的技术。之前接触过的产品中,除了几家引入了机器学习,还有几家是接入了现有的语义模型,而且结果很成功。但语义模型相对计算机最基础和最重要的算法就差得远了,很多时候机器学习是提高app品质的基础,你只是用机器学习去做了重复的事情,自然不能保证方方面面。

两个方面,数据采集和自动组合。数据采集的流程基本是各家app都会有的,或者需要单独去做的,简单讲,大致是用户量大,数据收集量大的app,才需要做这些工作。整理好的信息用户只需要付出一定的paid成本,比如登录、注册,这样。

用Python采集上海3000家医院数据,并进行可视化分析

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2022-04-28 21:06

大家好,我是J哥。

细心的朋友应该已经发现,我昨天在视频号更新了一个有意思的视频,还没观看的阔以戳下方

:

很多小伙伴非常感兴趣,纷纷私信J哥教程。其实整个内容还是比较简单的,用到的技巧在本公众号都能找到文章与之对应,包括爬虫、pandas数据处理、自动化办公、数据可视化等内容。

一、数据采集

数据来源于高德开放平台的POI数据,需要提前在高德开放平台注册并创建应用,获取你的专属key。

高德地图开放平台当然,你也可以通过百度地图开放平台或腾讯地图开放平台获取相关数据,方法都差不多。

POI数据很多,你可以自定义地理区域和类别进行数据采集,这里我只采集了上海16个区的综合医院地理数据。

# -*- coding: utf-8 -*-<br />import requests<br />import json<br />from urllib.parse import quote<br />import xlwt<br />from fake_useragent import UserAgent<br />from Coordin_transformlat import gcj02towgs84<br /><br />def get_data(key, city, types, page):<br /> '''调用POI '''<br /> headers= {'User-Agent':str(UserAgent().random)}<br /> url = f'https://restapi.amap.com/v3/place/text?key={key}&types={types}&city={quote(city)}&page={page}&output=josn'<br /> r = requests.get(url, headers=headers,timeout=2)<br /> r.encoding = 'utf-8'<br /> data = r.text<br /> return data<br /><br />def get_num(key, city, types):<br /> '''控制申请次数'''<br /><br /><br />def save_data(poilist, city,types):<br /> '''保存到excel'''<br /> <br /><br />if __name__ == "__main__":<br /> #高德密钥<br /> key = '你自己的key' #高德开放平台申请即可<br /> types = ['综合医院']<br /> city_list = ['黄浦区','徐汇区','长宁区','静安区','普陀区','闸北区','虹口区','杨浦区','浦东新区',<br /> '奉贤区','青浦区','松江区','嘉定区','金山区','闵行区','宝山区']<br /> for city in city_list:<br /> for type in types:<br /> poi = get_num(key,city,type)<br /> print(f'{city}的{type}共有{len(poi)}条数据')<br /> save_data(poi,city,type)<br /> print(f'{city}的{type}写入成功')<br /> print('数据获取完成')

整个数据采集逻辑比较简单,带着你的key和关键字向高德平台请求数据,保存为excel即可。这里需要注意的是平台对普通开发者有请求次数限制,咱们可以通过遍历行政区(而非整个城市)的方式,尽可能获取更全面的数据。

数据请求完后,共采集到大概3000条数据,得到16个excel表格:

二、数据处理

为了便于分析,咱们需要将16个excel表格数据合并为一个df,自然少不了pandas大法。excel合并的操作其实前年J哥就进行了详细讲解:

import pandas as pd<br />from pathlib import Path<br /><br />files = Path("./").glob("*.xls")<br />dfs = [pd.read_excel(f) for f in files]<br />df = pd.concat(dfs)

另外,我发现数据集存在缺失值,5个异常值,这会影响后面的地图可视化,因此,咱们用0填充缺失值,筛选出需要的字段和数据(纬度小于32)。

<p>df = df.fillna(0) #填充缺失值<br />df = df[['lon','lat','name','address','adname']] #筛选需要的字段<br />df = df[(df['lat'] 查看全部

用Python采集上海3000家医院数据,并进行可视化分析

大家好,我是J哥。

细心的朋友应该已经发现,我昨天在视频号更新了一个有意思的视频,还没观看的阔以戳下方

:

很多小伙伴非常感兴趣,纷纷私信J哥教程。其实整个内容还是比较简单的,用到的技巧在本公众号都能找到文章与之对应,包括爬虫、pandas数据处理、自动化办公、数据可视化等内容。

一、数据采集

数据来源于高德开放平台的POI数据,需要提前在高德开放平台注册并创建应用,获取你的专属key。

高德地图开放平台当然,你也可以通过百度地图开放平台或腾讯地图开放平台获取相关数据,方法都差不多。

POI数据很多,你可以自定义地理区域和类别进行数据采集,这里我只采集了上海16个区的综合医院地理数据。

# -*- coding: utf-8 -*-<br />import requests<br />import json<br />from urllib.parse import quote<br />import xlwt<br />from fake_useragent import UserAgent<br />from Coordin_transformlat import gcj02towgs84<br /><br />def get_data(key, city, types, page):<br /> '''调用POI '''<br /> headers= {'User-Agent':str(UserAgent().random)}<br /> url = f'https://restapi.amap.com/v3/place/text?key={key}&types={types}&city={quote(city)}&page={page}&output=josn'<br /> r = requests.get(url, headers=headers,timeout=2)<br /> r.encoding = 'utf-8'<br /> data = r.text<br /> return data<br /><br />def get_num(key, city, types):<br /> '''控制申请次数'''<br /><br /><br />def save_data(poilist, city,types):<br /> '''保存到excel'''<br /> <br /><br />if __name__ == "__main__":<br /> #高德密钥<br /> key = '你自己的key' #高德开放平台申请即可<br /> types = ['综合医院']<br /> city_list = ['黄浦区','徐汇区','长宁区','静安区','普陀区','闸北区','虹口区','杨浦区','浦东新区',<br /> '奉贤区','青浦区','松江区','嘉定区','金山区','闵行区','宝山区']<br /> for city in city_list:<br /> for type in types:<br /> poi = get_num(key,city,type)<br /> print(f'{city}的{type}共有{len(poi)}条数据')<br /> save_data(poi,city,type)<br /> print(f'{city}的{type}写入成功')<br /> print('数据获取完成')

整个数据采集逻辑比较简单,带着你的key和关键字向高德平台请求数据,保存为excel即可。这里需要注意的是平台对普通开发者有请求次数限制,咱们可以通过遍历行政区(而非整个城市)的方式,尽可能获取更全面的数据。

数据请求完后,共采集到大概3000条数据,得到16个excel表格:

二、数据处理

为了便于分析,咱们需要将16个excel表格数据合并为一个df,自然少不了pandas大法。excel合并的操作其实前年J哥就进行了详细讲解:

import pandas as pd<br />from pathlib import Path<br /><br />files = Path("./").glob("*.xls")<br />dfs = [pd.read_excel(f) for f in files]<br />df = pd.concat(dfs)

另外,我发现数据集存在缺失值,5个异常值,这会影响后面的地图可视化,因此,咱们用0填充缺失值,筛选出需要的字段和数据(纬度小于32)。

<p>df = df.fillna(0) #填充缺失值<br />df = df[['lon','lat','name','address','adname']] #筛选需要的字段<br />df = df[(df['lat']

采集自动组合( 适配器管理用来展示元数据系统支持的所有适配器列表(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 358 次浏览 • 2022-04-19 14:12

适配器管理用来展示元数据系统支持的所有适配器列表(组图))

1.适配器管理

适配器管理用于显示元数据系统支持的所有适配器的列表。点击查看各个适配器的详细信息,不可添加、编辑、删除。

适配器分为国内数据库、大型数据库、关系数据库、报表工具、建模工具、数据处理工具等7类。

单击适配器名称,可以查看适配器的基本信息和配置信息。例如,JDBC 驱动程序采集 适配器。在配置信息中,列出了需要为适配器设置的参数。

点击

进入新的 采集 向导以快速创建新的数据源和 采集 任务。

2.数据源管理

在数据源管理界面,列出系统当前所有的数据源

点击新建添加新数据源,并配置相关参数采集将数据库中的元数据信息到指定目录

数据源名称:设置数据源的名称;

· 审核:如果这里选择“是”,则所有采集数据都需要审核入库;

Adapter:为此数据源选择适用的适配器;

工具版本:选择适配器的版本;

·采集模式:根据选择的适配器默认生成;

·数据源挂载路径:选择数据源的挂载点。

描述:描述数据源

以上基本信息设置好后,点击下一步。下面以JDBC驱动采集适配器为例介绍参数配置

• 需要 采集 的架构:您可以指定需要 采集 的架构

• 是否将表/字段注释作为表/字段名称:可以设置是否将表/字段作为元数据名称

上图中,在下拉框中选择数据库类型为DB2,在参数列表的参数值中设置各个参数值,点击连接测试。测试通过后,点击保存,保存数据源。

注意:(1)同一驱动、url、用户名、挂载点只能添加一个数据源

(2)JDBC采集支持driverFiles参数指定驱动路径

(3)JDBC采集支持otherParams参数配置扩展属性

(4)库表采集适配器”或“JDBC驱动程序采集适配器”采集

(5)元数据数据源信息数据库密码密文显示

点击编辑修改数据源

修改数据源参数配置

如果采集适配器为“Library Table采集Adapter”或“JDBKC Driver采集Adapter”,参数配置完成后,点击左下角的【下一步】按钮,然后单击过滤元数据采集。

从左侧页面选择需要过滤的元数据类型,然后勾选右侧的【收录】或【排除】,在对应的文本框中输入数据

笔记:

【勾选选项】左侧选择的元数据类型需要为采集可以勾选此项,文本框中输入的表名、字段名等正则表达式为指定要存储的数据。

【排除】左侧选择的元数据类型不需要采集,可以勾选此项,在文本框中输入不需要采集的表名、字段名等正则表达式, 采集 根据模糊匹配结果过滤后,数据入库

3.采集任务配置

定义好数据源后,需要新建一个采集任务,周期性地将采集数据发送到业务系统。在采集任务配置界面,可以添加和删除采集任务,分组采集任务,禁用和启用采集任务。

点击New弹出新建采集任务向导

在任务计划向导中,选择需要采集数据的数据源,是否自动发布,存储策略。当自动发布选择“是”时,最新的元数据可以作为最终元数据自动发布。存储策略分为全量、增量、保守更新和激进更新。不同的是,数据源中的所有数据都存储在数据库中,增量数据是新增或修改的。保守更新是基于增量更新保留最新元数据的现有名称和属性值,点击下一步,

详细说明:

全量:比较这个采集的元数据和挂载点下的数据,删除挂载点下的冗余数据,更新不一致的数据,添加缺失的数据;

增量:保留挂载点下的现有数据。当采集元数据的代码和路径与已有元数据相同且名称和属性值不完全相同时,采集元数据会更新挂载下对应的元数据观点;

保守更新:保留挂载点下已有的数据。当采集元数据的代码和路径与现有元数据相同且名称和属性值不相同时,如果采集元数据与现有元数据具有相同的代码和路径metadata 当名称和属性值不为空时,将元数据不为空的采集的值更新为已有的元数据。采集如果元数据属性值为空,则对应的属性值不会改变。

激进更新:比较挂载点和采集源中的元数据,删除挂载点下多余的元数据,添加缺失的元数据,增量更新最新元数据的现有名称和属性值。

设置相应的调度执行时间。设置任务的执行时间,请根据具体情况和需要来决定。需要注意的是,名称必须是唯一的。

点击采集任务名称,查看对应的采集任务日志

将挂载点与采集源中的元数据进行比较,删除挂载点下多余的元数据,添加缺失的元数据,增量更新最新元数据的现有名称和属性值。

4.采集日志

在采集日志界面可以查看采集任务的执行情况,或者点击导出按钮导出采集日志

5.入站审核

如果在创建新数据源时选择需要审核,则需要审核的采集任务将在此页面列出。

入库审核分为待审核、已审核、退货3个标签页。

单击详细信息以查看数据更改及其依赖关系。

在要审核的数据中,选择更改类型为“添加”、“修改”或“删除”。更改类型中显示了每种类型的总数,您可以查看每个更改的状态。

对于待审核的数据,您可以选择通过、返回或检查部分通过和部分返回的元数据,其余数据将保留在待审核页面上。

对于修改后的数据,可以查看审计跟踪。

在操作中单击“待审核详情”,可以查看该数据源的待审核数据和待审核关系。

单击操作中的已审核审核流程以查看此数据源的审核结果。

注意:左侧导航树不显示已传递或返回的元数据。传递和返回导航树的逻辑如下。

·根据组合关系,在新增的情况下

通过逻辑:检查元数据和上级元数据都通过

返回逻辑:选中的元数据和从属元数据都返回

· 根据组合关系修改情况

传递逻辑:检查哪些元数据要传递哪些元数据

返回同上:检查哪些元数据通过了哪些元数据

· 根据组合关系,删除案例

传递逻辑:通过检查的元数据和从属元数据

返回同上:勾选的元数据和低级元数据都通过

以上步骤完成后,采集对元数据的工作就完成了,接下来就是分析元数据了。

6.采集模板配置

元数据管理平台可以使用手动方式采集数据,但是手动采集时,不同的元数据类型,数据格式会有所不同,用户很难准确知道格式,导致在手动 采集 模板中很难。系统可以通过数据源生成标准文件,用户可以根据文件填写元数据信息,通过采集任务直接将元数据采集传给系统。

手动采集有两种应用场景,直接通过excel输入数据或者补充其他数据源的数据。如果数据是通过excel输入的,那么新建数据源时,需要选择Excel采集适配器;如果是补充数据,则在新建数据源时,选择Excel补充条目采集适配器。

在采集模板配置中,点击新建按钮,在采集模板管理中,输入模板名称,选择需要手动采集数据的数据源,勾选需要采集元数据类型,点击下一步,

确认每个excel文件的sheet页面后,点击OK生成采集模板

选择采集模板后,可以将基于采集模板对应的excel文件导出为采集模板。

注意:新创建的采集模板的状态默认显示为有效。重新发布模板对应的元模型时,模板状态显示为无效。重新编辑保存后,模板状态变为有效。 查看全部

采集自动组合(

适配器管理用来展示元数据系统支持的所有适配器列表(组图))

1.适配器管理

适配器管理用于显示元数据系统支持的所有适配器的列表。点击查看各个适配器的详细信息,不可添加、编辑、删除。

适配器分为国内数据库、大型数据库、关系数据库、报表工具、建模工具、数据处理工具等7类。

单击适配器名称,可以查看适配器的基本信息和配置信息。例如,JDBC 驱动程序采集 适配器。在配置信息中,列出了需要为适配器设置的参数。

点击

进入新的 采集 向导以快速创建新的数据源和 采集 任务。

2.数据源管理

在数据源管理界面,列出系统当前所有的数据源

点击新建添加新数据源,并配置相关参数采集将数据库中的元数据信息到指定目录

数据源名称:设置数据源的名称;

· 审核:如果这里选择“是”,则所有采集数据都需要审核入库;

Adapter:为此数据源选择适用的适配器;

工具版本:选择适配器的版本;

·采集模式:根据选择的适配器默认生成;

·数据源挂载路径:选择数据源的挂载点。

描述:描述数据源

以上基本信息设置好后,点击下一步。下面以JDBC驱动采集适配器为例介绍参数配置

• 需要 采集 的架构:您可以指定需要 采集 的架构

• 是否将表/字段注释作为表/字段名称:可以设置是否将表/字段作为元数据名称

上图中,在下拉框中选择数据库类型为DB2,在参数列表的参数值中设置各个参数值,点击连接测试。测试通过后,点击保存,保存数据源。

注意:(1)同一驱动、url、用户名、挂载点只能添加一个数据源

(2)JDBC采集支持driverFiles参数指定驱动路径

(3)JDBC采集支持otherParams参数配置扩展属性

(4)库表采集适配器”或“JDBC驱动程序采集适配器”采集

(5)元数据数据源信息数据库密码密文显示

点击编辑修改数据源

修改数据源参数配置

如果采集适配器为“Library Table采集Adapter”或“JDBKC Driver采集Adapter”,参数配置完成后,点击左下角的【下一步】按钮,然后单击过滤元数据采集。

从左侧页面选择需要过滤的元数据类型,然后勾选右侧的【收录】或【排除】,在对应的文本框中输入数据

笔记:

【勾选选项】左侧选择的元数据类型需要为采集可以勾选此项,文本框中输入的表名、字段名等正则表达式为指定要存储的数据。

【排除】左侧选择的元数据类型不需要采集,可以勾选此项,在文本框中输入不需要采集的表名、字段名等正则表达式, 采集 根据模糊匹配结果过滤后,数据入库

3.采集任务配置

定义好数据源后,需要新建一个采集任务,周期性地将采集数据发送到业务系统。在采集任务配置界面,可以添加和删除采集任务,分组采集任务,禁用和启用采集任务。

点击New弹出新建采集任务向导

在任务计划向导中,选择需要采集数据的数据源,是否自动发布,存储策略。当自动发布选择“是”时,最新的元数据可以作为最终元数据自动发布。存储策略分为全量、增量、保守更新和激进更新。不同的是,数据源中的所有数据都存储在数据库中,增量数据是新增或修改的。保守更新是基于增量更新保留最新元数据的现有名称和属性值,点击下一步,

详细说明:

全量:比较这个采集的元数据和挂载点下的数据,删除挂载点下的冗余数据,更新不一致的数据,添加缺失的数据;

增量:保留挂载点下的现有数据。当采集元数据的代码和路径与已有元数据相同且名称和属性值不完全相同时,采集元数据会更新挂载下对应的元数据观点;

保守更新:保留挂载点下已有的数据。当采集元数据的代码和路径与现有元数据相同且名称和属性值不相同时,如果采集元数据与现有元数据具有相同的代码和路径metadata 当名称和属性值不为空时,将元数据不为空的采集的值更新为已有的元数据。采集如果元数据属性值为空,则对应的属性值不会改变。

激进更新:比较挂载点和采集源中的元数据,删除挂载点下多余的元数据,添加缺失的元数据,增量更新最新元数据的现有名称和属性值。

设置相应的调度执行时间。设置任务的执行时间,请根据具体情况和需要来决定。需要注意的是,名称必须是唯一的。

点击采集任务名称,查看对应的采集任务日志

将挂载点与采集源中的元数据进行比较,删除挂载点下多余的元数据,添加缺失的元数据,增量更新最新元数据的现有名称和属性值。

4.采集日志

在采集日志界面可以查看采集任务的执行情况,或者点击导出按钮导出采集日志

5.入站审核

如果在创建新数据源时选择需要审核,则需要审核的采集任务将在此页面列出。

入库审核分为待审核、已审核、退货3个标签页。

单击详细信息以查看数据更改及其依赖关系。

在要审核的数据中,选择更改类型为“添加”、“修改”或“删除”。更改类型中显示了每种类型的总数,您可以查看每个更改的状态。

对于待审核的数据,您可以选择通过、返回或检查部分通过和部分返回的元数据,其余数据将保留在待审核页面上。

对于修改后的数据,可以查看审计跟踪。

在操作中单击“待审核详情”,可以查看该数据源的待审核数据和待审核关系。

单击操作中的已审核审核流程以查看此数据源的审核结果。

注意:左侧导航树不显示已传递或返回的元数据。传递和返回导航树的逻辑如下。

·根据组合关系,在新增的情况下

通过逻辑:检查元数据和上级元数据都通过

返回逻辑:选中的元数据和从属元数据都返回

· 根据组合关系修改情况

传递逻辑:检查哪些元数据要传递哪些元数据

返回同上:检查哪些元数据通过了哪些元数据

· 根据组合关系,删除案例

传递逻辑:通过检查的元数据和从属元数据

返回同上:勾选的元数据和低级元数据都通过

以上步骤完成后,采集对元数据的工作就完成了,接下来就是分析元数据了。

6.采集模板配置

元数据管理平台可以使用手动方式采集数据,但是手动采集时,不同的元数据类型,数据格式会有所不同,用户很难准确知道格式,导致在手动 采集 模板中很难。系统可以通过数据源生成标准文件,用户可以根据文件填写元数据信息,通过采集任务直接将元数据采集传给系统。

手动采集有两种应用场景,直接通过excel输入数据或者补充其他数据源的数据。如果数据是通过excel输入的,那么新建数据源时,需要选择Excel采集适配器;如果是补充数据,则在新建数据源时,选择Excel补充条目采集适配器。

在采集模板配置中,点击新建按钮,在采集模板管理中,输入模板名称,选择需要手动采集数据的数据源,勾选需要采集元数据类型,点击下一步,

确认每个excel文件的sheet页面后,点击OK生成采集模板

选择采集模板后,可以将基于采集模板对应的excel文件导出为采集模板。

注意:新创建的采集模板的状态默认显示为有效。重新发布模板对应的元模型时,模板状态显示为无效。重新编辑保存后,模板状态变为有效。

采集自动组合(采集自动组合抠图程序-leetcode每一行默认替换为100)

采集交流 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-04-18 08:03

采集自动组合抠图程序-leetcode每一行默认替换为100,也就是说程序会保留这100行一共一万五千五百个点图像。大小为十六进制的600k-700k。

如果是完全覆盖要是精确到xxx个点一行一帧是完全没问题的。importtornadoimporttornado.messagestornado.io.client.run((socket,streamwriter,streamreader,arraytimer,log)))client=tornado.new("")definit_socket(self):self.socket=socket(default=any)try:client.socket.read(self.data,。

2)exceptexceptionase:printe.statusprint"error:"+e.statusclient.socket.recv(self.data,2

0)client.socket.send(self.data,2

0)

128bit?那总共60000个点一帧?128bit乘以一秒60fps是54000/60fps除以60fps是48.5fps

没多久见过网页的1,我用spine这种简单的做了一个。不知道怎么做的对不对。先找了一下。然后试了试,发现这种效果可以加json或者io库来实现,同时也可以用client(abstloadingexerciseonline)实现。但是我做了这个以后发现要满足这个速度必须得很高端的node或者meteor或者c++。

不知道现在是怎么做的。spyder用的是selenium2来调用client/server,而且效果几乎是没有的。intellijidea貌似有api写maps(json-any-client-to-webgl)之类的,也有相应实现。但是开发者自己实现的maps貌似只提供了一个字段,并且每个页面都有maps名字。

参考下文:client–openstreamwithguispecification,renderingforallprojectswiththetypesofuicomponents(csv)–python(1.。

2)apidocumentation然后abalance有一个插件可以让webgl打开一个url,并计算所有url的转化数据(必须是公网地址),这个需要你的站点足够强大,不然一个new就20000帧啦,而且还要new完之后计算转化数据。一般来说,这种问题可以用asyncio解决,不一定非要弄成一个函数,生成事件监听,在web设备输入时取并计算。asyncio-asyncio。 查看全部

采集自动组合(采集自动组合抠图程序-leetcode每一行默认替换为100)

采集自动组合抠图程序-leetcode每一行默认替换为100,也就是说程序会保留这100行一共一万五千五百个点图像。大小为十六进制的600k-700k。

如果是完全覆盖要是精确到xxx个点一行一帧是完全没问题的。importtornadoimporttornado.messagestornado.io.client.run((socket,streamwriter,streamreader,arraytimer,log)))client=tornado.new("")definit_socket(self):self.socket=socket(default=any)try:client.socket.read(self.data,。

2)exceptexceptionase:printe.statusprint"error:"+e.statusclient.socket.recv(self.data,2

0)client.socket.send(self.data,2

0)

128bit?那总共60000个点一帧?128bit乘以一秒60fps是54000/60fps除以60fps是48.5fps

没多久见过网页的1,我用spine这种简单的做了一个。不知道怎么做的对不对。先找了一下。然后试了试,发现这种效果可以加json或者io库来实现,同时也可以用client(abstloadingexerciseonline)实现。但是我做了这个以后发现要满足这个速度必须得很高端的node或者meteor或者c++。

不知道现在是怎么做的。spyder用的是selenium2来调用client/server,而且效果几乎是没有的。intellijidea貌似有api写maps(json-any-client-to-webgl)之类的,也有相应实现。但是开发者自己实现的maps貌似只提供了一个字段,并且每个页面都有maps名字。

参考下文:client–openstreamwithguispecification,renderingforallprojectswiththetypesofuicomponents(csv)–python(1.。

2)apidocumentation然后abalance有一个插件可以让webgl打开一个url,并计算所有url的转化数据(必须是公网地址),这个需要你的站点足够强大,不然一个new就20000帧啦,而且还要new完之后计算转化数据。一般来说,这种问题可以用asyncio解决,不一定非要弄成一个函数,生成事件监听,在web设备输入时取并计算。asyncio-asyncio。

采集自动组合(一下京东关键词优化技巧介绍-小编京东优化方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2022-04-13 03:28

职称对于京东商户来说是必不可少的,职称是由关键词一一组成的,所以想要高职称一定要选择关键词。那么我来介绍一下京东的优化技巧关键词。

京东关键词优化提示

一、关键词采集

在关键词的选择上,作为商家,这个时候需要多关注与产品高度相关的流量词和热词,采集都是向下。一般选词有三种方式,一是通过京东搜索引擎选择合适的关键词,二是从京东商业智能的行业关键词中选择,最后一种是就是通过快车的产品推送词来选择合适的关键词。所以,在关键词这个区域,采集越多,能够组合的概率就越高,所以关键词采集一定不能马虎。

二、关键词过滤器

在完成关键词的采集之后,下一步就是过滤采集finished关键词。筛选出采集收到的所有关键词,然后选择与自己的产品最相关、流量大、引流效果好的。是的,关键词。

三、关键词组合

标题越多越好,至少在京东,标题越短,得分越高。所以在组合关键词的时候,一定要多注意标题的长度,除了另外要注意关键词和关键词的顺序的距离,会影响标题的分数。一般来说,关键词的组合多为品牌词+热搜词/流量词+产品名称+产品卖点+规格+关键词。

总之,京东对关键词组合的要求还是很精准的。商家在填写关键词时,可以在了解产品和产品消费者之前进行市场调研。经过搜索习惯,我们可以更好的优化关键词。 查看全部

采集自动组合(一下京东关键词优化技巧介绍-小编京东优化方法)

职称对于京东商户来说是必不可少的,职称是由关键词一一组成的,所以想要高职称一定要选择关键词。那么我来介绍一下京东的优化技巧关键词。

京东关键词优化提示

一、关键词采集

在关键词的选择上,作为商家,这个时候需要多关注与产品高度相关的流量词和热词,采集都是向下。一般选词有三种方式,一是通过京东搜索引擎选择合适的关键词,二是从京东商业智能的行业关键词中选择,最后一种是就是通过快车的产品推送词来选择合适的关键词。所以,在关键词这个区域,采集越多,能够组合的概率就越高,所以关键词采集一定不能马虎。

二、关键词过滤器

在完成关键词的采集之后,下一步就是过滤采集finished关键词。筛选出采集收到的所有关键词,然后选择与自己的产品最相关、流量大、引流效果好的。是的,关键词。

三、关键词组合

标题越多越好,至少在京东,标题越短,得分越高。所以在组合关键词的时候,一定要多注意标题的长度,除了另外要注意关键词和关键词的顺序的距离,会影响标题的分数。一般来说,关键词的组合多为品牌词+热搜词/流量词+产品名称+产品卖点+规格+关键词。

总之,京东对关键词组合的要求还是很精准的。商家在填写关键词时,可以在了解产品和产品消费者之前进行市场调研。经过搜索习惯,我们可以更好的优化关键词。

采集自动组合(智能优采云采集器数据采集可根据不同网站公开(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-04-12 16:28

优采云采集器是一个非常实用和强大的网页数据采集器,涵盖金融、交易、社交网站、电商产品等广泛的领域。< @网站数据可以正常采集向下并可以导出,软件界面非常简洁明了,使用方便快捷,让你繁琐复杂的工作变得简单有趣!

功能说明

简单采集

简单的采集模式,内置数百个主流网站数据源,如京东、天猫、大众点评等流行的采集网站,只需参考模板只需简单设置参数,即可快速获取公共数据网站。

智能采集

优采云采集根据不同网站,提供多种网页采集策略及配套资源,可自定义配置、组合使用、自动处理。从而帮助整个采集流程实现数据的完整性和稳定性。

云采集

云采集支持5000多台云服务器,7*24小时不间断运行,可实现定时采集,无需人员值守,灵活贴合业务场景,助您提升采集效率,保证数据的及时性。

API接口

通过优采云 API,可以轻松获取优采云任务信息和采集获取的数据,灵活调度任务,如远程控制任务启动和停止,高效实现数据采集 和归档 . 基于强大的API系统,还可以与公司内部的各种管理平台无缝对接,实现各种业务自动化。

自定义采集

根据不同用户的采集需求,优采云可以提供自定义模式自动生成爬虫,可以批量准确识别各种网页元素,以及翻页、下拉、ajax 、页面滚动、条件判断等多种功能,支持复杂的网站采集网页结构,满足多种采集应用场景。

便捷的计时功能

只需简单的点击几下设置,即可实现对采集任务的定时控制,无论是单个采集定时设置,还是预设日或周、月定时采集,您可以同时自由设置多个任务,根据需要进行选择时间的多种组合,灵活部署自己的采集任务。

全自动数据格式化

优采云内置强大的数据格式化引擎,支持字符串替换、正则表达式替换或匹配、去除空格、添加前缀或后缀、日期时间格式化、HTML转码等多项功能,采集全自动处理过程中,无需人工干预,即可获得所需的格式数据。

多级采集

很多主流新闻和电商网站s包括一级产品listing页面、二级产品详情页、三级评论详情页;无论网站有多少层级,优采云都可以拥有无限层级的采集数据,满足各种业务采集的需求。

支持网站登录后采集

优采云内置采集登录模块,只需要配置目标网站的账号密码,即可使用该模块采集登录数据; 同时,优采云还带有采集cookie自定义功能,首次登录后可以自动记住cookie,免去多次输入密码的繁琐,支持更多采集网站 的@>。 查看全部

采集自动组合(智能优采云采集器数据采集可根据不同网站公开(组图))

优采云采集器是一个非常实用和强大的网页数据采集器,涵盖金融、交易、社交网站、电商产品等广泛的领域。< @网站数据可以正常采集向下并可以导出,软件界面非常简洁明了,使用方便快捷,让你繁琐复杂的工作变得简单有趣!

功能说明

简单采集

简单的采集模式,内置数百个主流网站数据源,如京东、天猫、大众点评等流行的采集网站,只需参考模板只需简单设置参数,即可快速获取公共数据网站。

智能采集

优采云采集根据不同网站,提供多种网页采集策略及配套资源,可自定义配置、组合使用、自动处理。从而帮助整个采集流程实现数据的完整性和稳定性。

云采集

云采集支持5000多台云服务器,7*24小时不间断运行,可实现定时采集,无需人员值守,灵活贴合业务场景,助您提升采集效率,保证数据的及时性。

API接口

通过优采云 API,可以轻松获取优采云任务信息和采集获取的数据,灵活调度任务,如远程控制任务启动和停止,高效实现数据采集 和归档 . 基于强大的API系统,还可以与公司内部的各种管理平台无缝对接,实现各种业务自动化。

自定义采集

根据不同用户的采集需求,优采云可以提供自定义模式自动生成爬虫,可以批量准确识别各种网页元素,以及翻页、下拉、ajax 、页面滚动、条件判断等多种功能,支持复杂的网站采集网页结构,满足多种采集应用场景。

便捷的计时功能

只需简单的点击几下设置,即可实现对采集任务的定时控制,无论是单个采集定时设置,还是预设日或周、月定时采集,您可以同时自由设置多个任务,根据需要进行选择时间的多种组合,灵活部署自己的采集任务。

全自动数据格式化

优采云内置强大的数据格式化引擎,支持字符串替换、正则表达式替换或匹配、去除空格、添加前缀或后缀、日期时间格式化、HTML转码等多项功能,采集全自动处理过程中,无需人工干预,即可获得所需的格式数据。

多级采集

很多主流新闻和电商网站s包括一级产品listing页面、二级产品详情页、三级评论详情页;无论网站有多少层级,优采云都可以拥有无限层级的采集数据,满足各种业务采集的需求。

支持网站登录后采集

优采云内置采集登录模块,只需要配置目标网站的账号密码,即可使用该模块采集登录数据; 同时,优采云还带有采集cookie自定义功能,首次登录后可以自动记住cookie,免去多次输入密码的繁琐,支持更多采集网站 的@>。

采集自动组合(优采云采集器3,网站内容自动更新利器,独立的绿色软件,稳定易用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2022-04-07 22:24

优采云采集器3、网站自动内容更新工具,独立绿色软件,稳定好用,资讯必备采集。【全自动无人值守】无需人工值守,24小时自动实时监控目标,实时高效采集,全天候为您提供内容更新。满足长期运营需求,让你从繁重的工作中解脱出来【广泛适用】功能最全的采集软件,支持任意类型的网站采集,适用率高达9 9. 9%,支持发布到各类网站程序,甚至采集本地文件,免界面发布。【信息随心所欲】支持信息自由组合,通过强大的数据排序功能对信息进行深度处理,并创建新内容【任意格式文件下载】无论是静态还是动态,无论是图片、音乐、电影、软件,还是PDF文档、WORD文档,甚至是torrent文件,只要你想要[伪原创 】高速同义词替换,多词随机替换,段落随机排序,帮助内容SEO【无限多级页面采集】无论是垂直方向的页面,还是平行方向的多个分页,还是AJAX调用页面,轻松搞定采集【免费扩展】开放接口模式,可以自由二次开发,自定义任何功能,实现所有需求。软件内置discuzX、phpwind、dedecms、wordpress、phpcms、empirecms、dongyi、joomla、pbdigg、php168、bbsxp、phpbb、dvbbs、typecho、 查看全部

采集自动组合(优采云采集器3,网站内容自动更新利器,独立的绿色软件,稳定易用)