网页源代码抓取工具

网页源代码抓取工具(如何最高效地从海量信息里获取数据?(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-03-09 17:06

)

齐鲁晚报5月19日电:数据进入各行各业并得到广泛应用,应用随之而来的是数据的获取和精准挖掘。我们可以应用的大部分数据来自内部资源库和外部运营商。内部数据已集成并可以使用,而外部数据则需要先获取。外部数据的最大载体是互联网。网页中无数的增量数据收录了很多对我们有用的信息。

如何最有效地从海量信息中获取数据?网页抓取工具优采云采集器有大招,用自动化的智能工具代替人工采集数据,当然效率更高,准确率更高。

一、数据抓取的一般性

优采云采集器作为一款通用的网页抓取工具,基于源码的优采云采集器工作原理,允许99%的网页类型可以抓取,并具有自动登录、验证码识别、IP代理和其他功能以应对网站预防采集措施;采集对象的格式可以是文本、图片、音频、文件等,无需繁琐的操作,数据采集简单。

二、数据抓取的效率

效率是大数据时代对数据应用的又一重要要求。随着信息的爆炸式增长,如果跟不上速度,就会错过数据利用的最佳节点,因此数据获取的效率非常高。过去我们手动采集一天要抓取数百条数据,但是当网页抓取工具稳定运行时,每天可以达到10万条,比手动采集好几百倍。

三、数据采集的准确性

长期用肉眼辨别和提取信息可能会造成疲劳,但软件识别可以继续提取,准确率很高。但是需要注意的是,当采集不同类型的网站或者数据时,优采云采集器配置的规则是不同的。准确性。

响应大数据时代的号召,重视数据资源,善用网络抓取工具优采云采集器和优采云浏览器,轻松将数据收进包里,实现数据资产的高利用率和价值实现!

查看全部

网页源代码抓取工具(如何最高效地从海量信息里获取数据?(组图)

)

齐鲁晚报5月19日电:数据进入各行各业并得到广泛应用,应用随之而来的是数据的获取和精准挖掘。我们可以应用的大部分数据来自内部资源库和外部运营商。内部数据已集成并可以使用,而外部数据则需要先获取。外部数据的最大载体是互联网。网页中无数的增量数据收录了很多对我们有用的信息。

如何最有效地从海量信息中获取数据?网页抓取工具优采云采集器有大招,用自动化的智能工具代替人工采集数据,当然效率更高,准确率更高。

一、数据抓取的一般性

优采云采集器作为一款通用的网页抓取工具,基于源码的优采云采集器工作原理,允许99%的网页类型可以抓取,并具有自动登录、验证码识别、IP代理和其他功能以应对网站预防采集措施;采集对象的格式可以是文本、图片、音频、文件等,无需繁琐的操作,数据采集简单。

二、数据抓取的效率

效率是大数据时代对数据应用的又一重要要求。随着信息的爆炸式增长,如果跟不上速度,就会错过数据利用的最佳节点,因此数据获取的效率非常高。过去我们手动采集一天要抓取数百条数据,但是当网页抓取工具稳定运行时,每天可以达到10万条,比手动采集好几百倍。

三、数据采集的准确性

长期用肉眼辨别和提取信息可能会造成疲劳,但软件识别可以继续提取,准确率很高。但是需要注意的是,当采集不同类型的网站或者数据时,优采云采集器配置的规则是不同的。准确性。

响应大数据时代的号召,重视数据资源,善用网络抓取工具优采云采集器和优采云浏览器,轻松将数据收进包里,实现数据资产的高利用率和价值实现!

网页源代码抓取工具(car_亚马逊商品表亚马逊中国的数据验证码有时会不时出现)

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2022-03-09 09:01

[i=s]本帖最后由 tuesday1 于 2018-9-22 08:25 编辑 [/i]规则名称:car_Amazon产品表 亚马逊产品搜索列表对于不同的搜索词显示略有不同,是嵌套的,但是规则仍然不是普遍的。

为什么网页源代码显示有100个item,但是我仍然在抓取HTML文件中显示的只有20个item,如何获取所有item信息才能得到

[i=s]本帖最后编辑于 2019-9-25 23:34。[/i] 任务名称: amazon_uni0818 下面有5条规则,每条规则因为失败而失败并重新定义,但仍有8条失败示例,编号为:[color = rgbArial] [color =#666666] [backcolor=rgb(243, 245, 246)] 什么失败

为什么要在这个级别抢——“级别抢亚马逊”在“LEDspotlight产品详情”中,第一个示例生产规则是[color=#ff0000],可以测试[/color],然后尝试抓住但它不起作用?

%3Dmobile&field-keywords=huawei+p10+case&sprefix=huawe%2Caps%2C1708 以上网址,规则名称是华为P10一楼,华为P10二楼,请帮我解决。

有时会时不时出现爬取亚马逊中国的数据验证码。如何访问我购买的终极版的编码平台?

[列表][*]标题:[亚马逊商品评论]#GooSeekerDataDIY#[*]分类:电子商务[*]网站:[/ b]Amazon[*][b][b][b]采集字段:[/b][/b]评论内容,在评论日,BA%9A%E9%A9%AC% E9% 80 % 8A% E5% 95% 86% E5% 93% 81% E8% AF% 84% E8% AE% BA] 亚马逊产品评论[/url] 页面;[*] 输入网址,或点击“输入多个网址”,然后点击“获取数据”; [*]点击“开始采集”按钮,采集完成后点击“打包”按钮下载数据。

您好,请问您是否定期抢美国亚马逊提供产品价格信息?我这里有一个微商城,专门做亚马逊商品,大概200~500个SKU,全是包包,需要每天刮更新价格数据

[列表][*]标题:[亚马逊产品搜索列表)#GooSeekerDataDIY#[*]类别:电子商务[*]网站:[ /b]亚马逊[*][b][b][b]采集字段:[/b][/b]产品名称,产品链接 80% 8A% E5% 95% 86% E5 %93% 81%E6%90%9C%E7%B4%A2%E5%88%97%E8%A1%A8]亚马逊产品搜索列表[/url]页面;[*]输入网址,或点击输入多个网址”,然后点击“获取数据”; [*]点击“开始采集”按钮,采集完成后点击“打包”按钮下载数据。

抓取地址

题目名称:Amazon Books - 想尝试gsc爬取亚马逊的图书信息,设置翻页,现在的情况是玩ds数码机爬取的时候,所有的爬取都在同一个页面上。抓取页面后会自动打开一个新窗口,然后点击本机不同的窗口。

为什么当时在爬销售排行榜数据,做了example mapping后,前三个是一组,后一个是一组,而且他的产品链接格式不正确?

亚马逊爬虫怎么样

如何使用爬虫软件全面爬取亚马逊产品评论数据。

根据您商店的分类,您可以完全抓取产品评论。

亚马逊如何与爬行动物作战。

2.以多种方式获取和查询数据,分类、组织和导出(1)根据Ebay货号自定义和导入数据,例如监控出价。

(2)您可以自定义导入数据,例如根据 Ebay 商品编号监控出价。

(3)可以自定义根据店铺URL导入数据,比如监控出价。

下面是一个电表计价软件和数据监控系统。1.多模态数据采集监控(1)可以根据关键词/类型/排序监控各种排名和产品价格等数据。

3.这个功能可以根据用户的实际需要进行定制。所有 Ebay 产品图片、名称、价格、详细描述和其他字段都可以自定义采集或导出为自定义格式以供您购物网站。

如何使用爬虫软件(例如 优采云collector)完全爬取亚马逊产品。

在尝试使用爬虫之前先嗅探它们。我用它来采集亚马逊产品评论。产品信息与产品信息相同。操作非常简单直观。按照教程一步一步来,非常复杂。他可以采集页面。

这是最好的亚马逊爬虫软件。

下载完成后,我们的手机里就会有一个对应的安装应用,我们可以点击下图的安装按钮。

如果要管理手机中的软件安装包,可以找到腾讯手机管家的软件管理功能界面。

进入腾讯手机管家的安装包管理功能界面后,我们可以对自己的手机安装包进行相应的管理。

爬虫可以搜索亚马逊商家数据吗?

首先要对需要采集的亚马逊商户店铺地址进行采集和分类,使用市面上常用的机车数据采集器、优采云亚马逊数据采集软件、八达通数据采集器等导入地址。数据采集软件,用于选择所需的数据,如产品名称、评论、热门产品、流行趋势等。

如何使用python爬虫搜索亚马逊美国关键词排名。

9.分析可以做多少权重关键词。

第三,我们对多个关键词进行排名后,就出现了做网站的目的。哪些关键词能给我们带来更多的流量和更高的转化率,这些好的转化率高的关键词自然需要我们更多的关注。

5.在内容页面输入长尾关键词。长尾关键词优于一个指标,并使用数量来推动目标关键词。

6.目标关键字围绕主要关键字完成。

2.做出关键词后,分析对手关键词。

为什么python爬虫爬不上亚马逊页面。

js加载的一些内容只有在电脑屏幕或鼠标移动到特定位置时才会动态加载。这些都没有体现在源码中,python爬虫只是爬取源码。如果你想满足你的需求,可以尝试使用phantomjs来模拟一个浏览器,祝你成功。

索要 Java 爬虫要求文档,最好是亚马逊。

关于爬虫,网上有很多从新手到基础爬虫的例子,这个过程也很快。

只说一些高级问题:爬虫如何伪装成你想要的终端和浏览器。

攀登结果会有所不同。

欢迎您参与牛交流研究(限2人)

Android驱动开发技术培训638883269

基带硬件技术交流654271105

射频技术培训班653766426

PCB版图交流群711189959

全智技术交流群 778228658

信息产业交流 651214441

驱动专家组628699443

IC设计技术交流221533727

上海及周边会员交流团 541905910

北京及周边会员交流群565836224

成都及周边地区会员交流群603449471

点击了解更多牛网交流课题组 查看全部

网页源代码抓取工具(car_亚马逊商品表亚马逊中国的数据验证码有时会不时出现)

[i=s]本帖最后由 tuesday1 于 2018-9-22 08:25 编辑 [/i]规则名称:car_Amazon产品表 亚马逊产品搜索列表对于不同的搜索词显示略有不同,是嵌套的,但是规则仍然不是普遍的。

为什么网页源代码显示有100个item,但是我仍然在抓取HTML文件中显示的只有20个item,如何获取所有item信息才能得到

[i=s]本帖最后编辑于 2019-9-25 23:34。[/i] 任务名称: amazon_uni0818 下面有5条规则,每条规则因为失败而失败并重新定义,但仍有8条失败示例,编号为:[color = rgbArial] [color =#666666] [backcolor=rgb(243, 245, 246)] 什么失败

为什么要在这个级别抢——“级别抢亚马逊”在“LEDspotlight产品详情”中,第一个示例生产规则是[color=#ff0000],可以测试[/color],然后尝试抓住但它不起作用?

%3Dmobile&field-keywords=huawei+p10+case&sprefix=huawe%2Caps%2C1708 以上网址,规则名称是华为P10一楼,华为P10二楼,请帮我解决。

有时会时不时出现爬取亚马逊中国的数据验证码。如何访问我购买的终极版的编码平台?

[列表][*]标题:[亚马逊商品评论]#GooSeekerDataDIY#[*]分类:电子商务[*]网站:[/ b]Amazon[*][b][b][b]采集字段:[/b][/b]评论内容,在评论日,BA%9A%E9%A9%AC% E9% 80 % 8A% E5% 95% 86% E5% 93% 81% E8% AF% 84% E8% AE% BA] 亚马逊产品评论[/url] 页面;[*] 输入网址,或点击“输入多个网址”,然后点击“获取数据”; [*]点击“开始采集”按钮,采集完成后点击“打包”按钮下载数据。

您好,请问您是否定期抢美国亚马逊提供产品价格信息?我这里有一个微商城,专门做亚马逊商品,大概200~500个SKU,全是包包,需要每天刮更新价格数据

[列表][*]标题:[亚马逊产品搜索列表)#GooSeekerDataDIY#[*]类别:电子商务[*]网站:[ /b]亚马逊[*][b][b][b]采集字段:[/b][/b]产品名称,产品链接 80% 8A% E5% 95% 86% E5 %93% 81%E6%90%9C%E7%B4%A2%E5%88%97%E8%A1%A8]亚马逊产品搜索列表[/url]页面;[*]输入网址,或点击输入多个网址”,然后点击“获取数据”; [*]点击“开始采集”按钮,采集完成后点击“打包”按钮下载数据。

抓取地址

题目名称:Amazon Books - 想尝试gsc爬取亚马逊的图书信息,设置翻页,现在的情况是玩ds数码机爬取的时候,所有的爬取都在同一个页面上。抓取页面后会自动打开一个新窗口,然后点击本机不同的窗口。

为什么当时在爬销售排行榜数据,做了example mapping后,前三个是一组,后一个是一组,而且他的产品链接格式不正确?

亚马逊爬虫怎么样

如何使用爬虫软件全面爬取亚马逊产品评论数据。

根据您商店的分类,您可以完全抓取产品评论。

亚马逊如何与爬行动物作战。

2.以多种方式获取和查询数据,分类、组织和导出(1)根据Ebay货号自定义和导入数据,例如监控出价。

(2)您可以自定义导入数据,例如根据 Ebay 商品编号监控出价。

(3)可以自定义根据店铺URL导入数据,比如监控出价。

下面是一个电表计价软件和数据监控系统。1.多模态数据采集监控(1)可以根据关键词/类型/排序监控各种排名和产品价格等数据。

3.这个功能可以根据用户的实际需要进行定制。所有 Ebay 产品图片、名称、价格、详细描述和其他字段都可以自定义采集或导出为自定义格式以供您购物网站。

如何使用爬虫软件(例如 优采云collector)完全爬取亚马逊产品。

在尝试使用爬虫之前先嗅探它们。我用它来采集亚马逊产品评论。产品信息与产品信息相同。操作非常简单直观。按照教程一步一步来,非常复杂。他可以采集页面。

这是最好的亚马逊爬虫软件。

下载完成后,我们的手机里就会有一个对应的安装应用,我们可以点击下图的安装按钮。

如果要管理手机中的软件安装包,可以找到腾讯手机管家的软件管理功能界面。

进入腾讯手机管家的安装包管理功能界面后,我们可以对自己的手机安装包进行相应的管理。

爬虫可以搜索亚马逊商家数据吗?

首先要对需要采集的亚马逊商户店铺地址进行采集和分类,使用市面上常用的机车数据采集器、优采云亚马逊数据采集软件、八达通数据采集器等导入地址。数据采集软件,用于选择所需的数据,如产品名称、评论、热门产品、流行趋势等。

如何使用python爬虫搜索亚马逊美国关键词排名。

9.分析可以做多少权重关键词。

第三,我们对多个关键词进行排名后,就出现了做网站的目的。哪些关键词能给我们带来更多的流量和更高的转化率,这些好的转化率高的关键词自然需要我们更多的关注。

5.在内容页面输入长尾关键词。长尾关键词优于一个指标,并使用数量来推动目标关键词。

6.目标关键字围绕主要关键字完成。

2.做出关键词后,分析对手关键词。

为什么python爬虫爬不上亚马逊页面。

js加载的一些内容只有在电脑屏幕或鼠标移动到特定位置时才会动态加载。这些都没有体现在源码中,python爬虫只是爬取源码。如果你想满足你的需求,可以尝试使用phantomjs来模拟一个浏览器,祝你成功。

索要 Java 爬虫要求文档,最好是亚马逊。

关于爬虫,网上有很多从新手到基础爬虫的例子,这个过程也很快。

只说一些高级问题:爬虫如何伪装成你想要的终端和浏览器。

攀登结果会有所不同。

欢迎您参与牛交流研究(限2人)

Android驱动开发技术培训638883269

基带硬件技术交流654271105

射频技术培训班653766426

PCB版图交流群711189959

全智技术交流群 778228658

信息产业交流 651214441

驱动专家组628699443

IC设计技术交流221533727

上海及周边会员交流团 541905910

北京及周边会员交流群565836224

成都及周边地区会员交流群603449471

点击了解更多牛网交流课题组

网页源代码抓取工具(网页源代码抓取工具+beautifulsoup=解决多个浏览器访问host不一致)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-03-09 03:02

网页源代码抓取工具requests+beautifulsoup==解决多个浏览器访问host不一致,浏览器同时开多个网页,相互post一致内容,操作属性值问题,

importrequestsimportbs4frombs4importbeautifulsoupurl='={}'headers={'user-agent':'mozilla/5.0(windowsnt6.1;win64;x6

4)applewebkit/537。36(khtml,likegecko)chrome/57。3004。126safari/537。36'}#请求头yieldrequests。get(url=url,headers=headers)url_text=yieldstr(url_text)#样式表plt。

rcparams['font。sans-serif']=['simhei']#返回内容body=requests。post(url_text,{'user-agent':'mozilla/5。0(windowsnt6。1;win64;x6。

4)applewebkit/537。36(khtml,likegecko)chrome/57。3004。126safari/537。36'},headers=headers)print(body)#解析(可以通过json格式下读取body内容)print(re。findall('*',body))print(body。slice(2,。

2))#返回结果 查看全部

网页源代码抓取工具(网页源代码抓取工具+beautifulsoup=解决多个浏览器访问host不一致)

网页源代码抓取工具requests+beautifulsoup==解决多个浏览器访问host不一致,浏览器同时开多个网页,相互post一致内容,操作属性值问题,

importrequestsimportbs4frombs4importbeautifulsoupurl='={}'headers={'user-agent':'mozilla/5.0(windowsnt6.1;win64;x6

4)applewebkit/537。36(khtml,likegecko)chrome/57。3004。126safari/537。36'}#请求头yieldrequests。get(url=url,headers=headers)url_text=yieldstr(url_text)#样式表plt。

rcparams['font。sans-serif']=['simhei']#返回内容body=requests。post(url_text,{'user-agent':'mozilla/5。0(windowsnt6。1;win64;x6。

4)applewebkit/537。36(khtml,likegecko)chrome/57。3004。126safari/537。36'},headers=headers)print(body)#解析(可以通过json格式下读取body内容)print(re。findall('*',body))print(body。slice(2,。

2))#返回结果

网页源代码抓取工具(如何通过Chrome开发者工具寻找一个网站上特定数据的抓取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2022-03-08 04:10

网上爬虫教程太多了,去知乎搜索,估计能找到不少于100篇。每个人都高兴地从互联网上刮下另一个 网站。但是只要对方网站更新,很有可能文章中的方法已经失效了。

每一个网站捕获的代码都不一样,但是背后的原理是一样的。对于绝大多数 网站 来说,爬取程序就是这样。今天的文章文章不讲任何具体的捕获网站,只讲一个常见的事情:

如何使用 Chrome DevTools 找到一种方法来抓取 网站 上的特定数据。

我这里演示的是Mac上的英文版Chrome,在Windows上使用中文版的方法是一样的。

> 查看网页源代码

右键单击网页,选择“查看页面源代码”,在新选项卡中显示与 URL 对应的 HTML 代码文本。

此功能不被视为“开发人员工具”的一部分,但非常常用。此内容与您直接从代码中向该 URL 发出 GET 请求(无论权限如何)所获得的内容相同。如果你能在这个源码页上搜索到你想要的内容,你可以按照它的规则通过regular、bs4、xpath等方式提取文本中的数据。

但是,对于许多异步加载数据的 网站,您无法从该页面中找到您想要的内容。或者因为权限、验证等限制,代码中得到的结果与页面显示不一致。在这些情况下,我们需要更强大的开发人员工具来提供帮助。

> 元素

在网页上右击选择“Inspect”进入Chrome开发者工具的元素选择器。在工具中是元素选项卡。

元素有几个功能:

从 Elements 工具中定位数据比我们之前在源代码中直接搜索更方便,因为您可以清楚地看到它所在的元素结构。但这里有一个特别提醒:

Elements中看到的代码不等于请求URL得到的返回值。

它是网页经过浏览器渲染后的最终效果,包括异步请求数据和浏览器本身对代码的优化更改。因此,您无法完全按照 Elements 中显示的结构获取元素,在这种情况下,您可能不会得到正确的结果。

> 网络

选择开发者工具中的Network选项卡,进入网络监控功能,也就是我们常说的“抓包”。

这是爬虫使用的最重要的功能。主要解决两个问题:

如何抓住什么

抓什么是指如何找到通过异步请求获取的数据的来源。

打开Network页面,打开记录,然后刷新页面,可以看到所有发送的请求,包括数据、JS、CSS、图片、文档等都会显示出来。您可以从请求列表中找到您的目标。

一个一个找到它们会很痛苦。分享几个tips:

找到收录数据的请求后,下一步是以编程方式获取数据。现在是第二个问题:如何捕捉它。

并不是所有的 URL 都可以直接通过 GET 获取(相当于在浏览器中打开地址),通常还要考虑以下几点:

请求方法,GET 或 POST。请求附带的参数数据。GET 和 POST 以不同的方式传递参数。头信息。常用的有user-agent、host、referer、cookie等。cookie是用来识别请求者身份的关键信息。对于需要登录的网站,这个值是必不可少的。网站 经常使用其他项目来识别请求的合法性。相同的请求可以在浏览器中完成,但不能在程序中完成。大多数情况下,标题信息不正确。您可以将这些信息从 Chrome 复制到程序中,从而绕过对方的限制。

通过单击列表中的特定请求,可以找到上述所有信息。

找到正确的请求,设置正确的方法,传递正确的参数和头信息,网站上的大部分信息都可以做到。

网络还有一个功能:右键点击列表,选择“Save as HAR with content”,保存到文件。该文件收录列表中所有请求的参数和返回值信息,方便您查找和分析。(实践中发现直接搜索往往无效,保存到文件后才能搜索)

除了 Elements 和 Network 之外,开发者工具中还有一些功能,例如:

来源,查看资源列表和调试 JS。

控制台,显示页面的错误和输出,可以执行JS代码。很多网站都会把彩蛋放在这里招募(找比较有名的网站试试)。

但这些功能与爬虫关系不大。如果开发 网站 并优化 网站 以提高速度,则需要处理其他功能。这里不多说。

总结一下,其实你应该牢记以下几点:

在“查看源代码”中可以看到的数据可以通过程序直接请求当前的URL来获取。Elements 中的 HTML 代码不等于请求返回值,只能作为辅助。在Network中用内容关键字搜索,或者保存为HAR文件后搜索,找到收录数据的实际请求,查看请求的具体信息,包括方法、头、参数等,复制到程序中使用。

了解了这些步骤后,网上的大部分资料都可以得到。说“解决一半问题”不是头条新闻。

当然,说起来容易一些,但是想要精通的话,还有很多细节需要考虑,还需要不断的练习。但是考虑到这几点,再看各种爬虫案例,思路就会更加清晰。 查看全部

网页源代码抓取工具(如何通过Chrome开发者工具寻找一个网站上特定数据的抓取)

网上爬虫教程太多了,去知乎搜索,估计能找到不少于100篇。每个人都高兴地从互联网上刮下另一个 网站。但是只要对方网站更新,很有可能文章中的方法已经失效了。

每一个网站捕获的代码都不一样,但是背后的原理是一样的。对于绝大多数 网站 来说,爬取程序就是这样。今天的文章文章不讲任何具体的捕获网站,只讲一个常见的事情:

如何使用 Chrome DevTools 找到一种方法来抓取 网站 上的特定数据。

我这里演示的是Mac上的英文版Chrome,在Windows上使用中文版的方法是一样的。

> 查看网页源代码

右键单击网页,选择“查看页面源代码”,在新选项卡中显示与 URL 对应的 HTML 代码文本。

此功能不被视为“开发人员工具”的一部分,但非常常用。此内容与您直接从代码中向该 URL 发出 GET 请求(无论权限如何)所获得的内容相同。如果你能在这个源码页上搜索到你想要的内容,你可以按照它的规则通过regular、bs4、xpath等方式提取文本中的数据。

但是,对于许多异步加载数据的 网站,您无法从该页面中找到您想要的内容。或者因为权限、验证等限制,代码中得到的结果与页面显示不一致。在这些情况下,我们需要更强大的开发人员工具来提供帮助。

> 元素

在网页上右击选择“Inspect”进入Chrome开发者工具的元素选择器。在工具中是元素选项卡。

元素有几个功能:

从 Elements 工具中定位数据比我们之前在源代码中直接搜索更方便,因为您可以清楚地看到它所在的元素结构。但这里有一个特别提醒:

Elements中看到的代码不等于请求URL得到的返回值。

它是网页经过浏览器渲染后的最终效果,包括异步请求数据和浏览器本身对代码的优化更改。因此,您无法完全按照 Elements 中显示的结构获取元素,在这种情况下,您可能不会得到正确的结果。

> 网络

选择开发者工具中的Network选项卡,进入网络监控功能,也就是我们常说的“抓包”。

这是爬虫使用的最重要的功能。主要解决两个问题:

如何抓住什么

抓什么是指如何找到通过异步请求获取的数据的来源。

打开Network页面,打开记录,然后刷新页面,可以看到所有发送的请求,包括数据、JS、CSS、图片、文档等都会显示出来。您可以从请求列表中找到您的目标。

一个一个找到它们会很痛苦。分享几个tips:

找到收录数据的请求后,下一步是以编程方式获取数据。现在是第二个问题:如何捕捉它。

并不是所有的 URL 都可以直接通过 GET 获取(相当于在浏览器中打开地址),通常还要考虑以下几点:

请求方法,GET 或 POST。请求附带的参数数据。GET 和 POST 以不同的方式传递参数。头信息。常用的有user-agent、host、referer、cookie等。cookie是用来识别请求者身份的关键信息。对于需要登录的网站,这个值是必不可少的。网站 经常使用其他项目来识别请求的合法性。相同的请求可以在浏览器中完成,但不能在程序中完成。大多数情况下,标题信息不正确。您可以将这些信息从 Chrome 复制到程序中,从而绕过对方的限制。

通过单击列表中的特定请求,可以找到上述所有信息。

找到正确的请求,设置正确的方法,传递正确的参数和头信息,网站上的大部分信息都可以做到。

网络还有一个功能:右键点击列表,选择“Save as HAR with content”,保存到文件。该文件收录列表中所有请求的参数和返回值信息,方便您查找和分析。(实践中发现直接搜索往往无效,保存到文件后才能搜索)

除了 Elements 和 Network 之外,开发者工具中还有一些功能,例如:

来源,查看资源列表和调试 JS。

控制台,显示页面的错误和输出,可以执行JS代码。很多网站都会把彩蛋放在这里招募(找比较有名的网站试试)。

但这些功能与爬虫关系不大。如果开发 网站 并优化 网站 以提高速度,则需要处理其他功能。这里不多说。

总结一下,其实你应该牢记以下几点:

在“查看源代码”中可以看到的数据可以通过程序直接请求当前的URL来获取。Elements 中的 HTML 代码不等于请求返回值,只能作为辅助。在Network中用内容关键字搜索,或者保存为HAR文件后搜索,找到收录数据的实际请求,查看请求的具体信息,包括方法、头、参数等,复制到程序中使用。

了解了这些步骤后,网上的大部分资料都可以得到。说“解决一半问题”不是头条新闻。

当然,说起来容易一些,但是想要精通的话,还有很多细节需要考虑,还需要不断的练习。但是考虑到这几点,再看各种爬虫案例,思路就会更加清晰。

网页源代码抓取工具(常见问题FAQ免费下载或者VIP会员专享资源能否直接商用?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2022-03-08 03:10

猜你在找什么

本网站所有源码和软件均由作者提供,并推荐网友采集整理!

本站提供的所有模块、软件等资源不提供任何技术服务,敬请注意!

如需商用,请支持正版。本站提供的课程仅供学习和研究!

资源每天实时更新。如果是压缩包解压密码,则始终为:

如果您侵犯了您的版权,请来信(email:)指出,本站将立即更正。

都超汇 » 小程序源码提取工具完美解包,最新脚本,一键提取小程序源码工具

常见问题解答

VIP会员免费下载或专属资源可以直接商业化吗?

本站所有资源版权归原作者所有。此处提供的资源仅供参考和学习使用,请勿直接用于商业用途。如因商业用途发生版权纠纷,一切责任由用户承担。更多信息请参考VIP介绍。

提示下载完成但无法解压或打开?

最常见的情况是下载不完整:可以将下载的压缩包与网盘容量进行对比。如果小于网盘指示的容量,就是这个原因。这是浏览器下载bug,建议使用百度网盘软件或迅雷下载。如果排除了这种情况,可以在对应资源底部留言,或者联系我们。

在资产介绍文章 中找不到示例图片?

对于PPT、KEY、Mockups、APP、网页模板等各类素材,文章中用于介绍的图片通常不收录在对应的可下载素材包中。这些相关的商业图片需要单独购买,本站不负责(也没有办法)找到来源。某些字体文件也是如此,但某些资产在资产包中会有字体下载链接列表。

杜朝晖 查看全部

网页源代码抓取工具(常见问题FAQ免费下载或者VIP会员专享资源能否直接商用?)

猜你在找什么

本网站所有源码和软件均由作者提供,并推荐网友采集整理!

本站提供的所有模块、软件等资源不提供任何技术服务,敬请注意!

如需商用,请支持正版。本站提供的课程仅供学习和研究!

资源每天实时更新。如果是压缩包解压密码,则始终为:

如果您侵犯了您的版权,请来信(email:)指出,本站将立即更正。

都超汇 » 小程序源码提取工具完美解包,最新脚本,一键提取小程序源码工具

常见问题解答

VIP会员免费下载或专属资源可以直接商业化吗?

本站所有资源版权归原作者所有。此处提供的资源仅供参考和学习使用,请勿直接用于商业用途。如因商业用途发生版权纠纷,一切责任由用户承担。更多信息请参考VIP介绍。

提示下载完成但无法解压或打开?

最常见的情况是下载不完整:可以将下载的压缩包与网盘容量进行对比。如果小于网盘指示的容量,就是这个原因。这是浏览器下载bug,建议使用百度网盘软件或迅雷下载。如果排除了这种情况,可以在对应资源底部留言,或者联系我们。

在资产介绍文章 中找不到示例图片?

对于PPT、KEY、Mockups、APP、网页模板等各类素材,文章中用于介绍的图片通常不收录在对应的可下载素材包中。这些相关的商业图片需要单独购买,本站不负责(也没有办法)找到来源。某些字体文件也是如此,但某些资产在资产包中会有字体下载链接列表。

杜朝晖

网页源代码抓取工具(Java网页源代码抓取工具的方法及方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-03-08 01:04

网页源代码抓取工具很多,你要找一个能够从本机电脑抓取txt文件的,然后用java进行解析。这里我推荐一款非常好用的爬虫工具,抓取模式是requests,支持python2,python3(python2不开源),java,c++.支持-web自动化环境等,支持多语言同时抓取。推荐链接::。

有啊,比如知乎,推荐一个——滴滴打车,有同学做了一个爬虫工具,满足了不同语言需求,自己下个试试吧。

简单起见,假设题主已经熟悉c++,可以通过c语言代码开发——包括封装一些对象调用的方法,或者是用windows下的用canvas,或者是vb写程序。实践过程中,遇到不能用python代码来实现的场景再加入python解决方案。方法太多了,这里只是拿出一个方法。

首先说明对于语言并不是必须的一个工具,当然如果你是为了在各种编程语言里做选择,那么还是必须有一个强大的语言来获取数据和处理数据的一个环境的工具才是python所必须的。针对爬虫(爬虫的爬取模式并不是所有的数据)工具基本上就是框架,当然,框架是有不同的模式的,在用框架开发之前,你应该对框架已经有了一定的了解。

单纯拿excel来说吧,excel的格式就包含了元数据(用于以后的数据处理)、数据分析(数据处理结果的质量,可编辑性,还有数据运算之类的)以及其他的一些基本操作功能。python的框架基本上也差不多。但是针对数据库的读写等操作,常用的框架都不太一样,比如pymysql就不是通过列表读取,而是通过索引来读取数据库。

而no_boost的boost框架则会非常注重读写的高级功能。类似的,我所知道的目前被广泛使用的python框架的读写模式:boost::read_mysql,这是python中非常常用的一个读写模式,而tornado的使用者则是使用mysqlbuilder这个数据库读写的模块。所以可以看出这样的文档,框架的数据模型并不是必须的,甚至往往可以说,这种框架的封装也是无用的。

我所知道的是一些基于工具链的框架,比如w3cschool的scrapy框架,这是一个非常优秀的框架,一个实验项目就花了一个星期就搞定了python入门教程|菜鸟教程另外就是web服务器(异步或异步),数据库(orm或pydroid)等一些和其他框架一样有优势,但是不利于简单封装python调用工具的功能。

至于html5是否有必要用框架来做相关的操作?这要看你的场景。你如果是一个异步爬虫,并且基本的对象都是其他框架封装的,那么用纯html5框架就行。如果你的对象本身不能用xml或者xhtml封装成对象,那就还是需要做些封装,才能方便调。 查看全部

网页源代码抓取工具(Java网页源代码抓取工具的方法及方法)

网页源代码抓取工具很多,你要找一个能够从本机电脑抓取txt文件的,然后用java进行解析。这里我推荐一款非常好用的爬虫工具,抓取模式是requests,支持python2,python3(python2不开源),java,c++.支持-web自动化环境等,支持多语言同时抓取。推荐链接::。

有啊,比如知乎,推荐一个——滴滴打车,有同学做了一个爬虫工具,满足了不同语言需求,自己下个试试吧。

简单起见,假设题主已经熟悉c++,可以通过c语言代码开发——包括封装一些对象调用的方法,或者是用windows下的用canvas,或者是vb写程序。实践过程中,遇到不能用python代码来实现的场景再加入python解决方案。方法太多了,这里只是拿出一个方法。

首先说明对于语言并不是必须的一个工具,当然如果你是为了在各种编程语言里做选择,那么还是必须有一个强大的语言来获取数据和处理数据的一个环境的工具才是python所必须的。针对爬虫(爬虫的爬取模式并不是所有的数据)工具基本上就是框架,当然,框架是有不同的模式的,在用框架开发之前,你应该对框架已经有了一定的了解。

单纯拿excel来说吧,excel的格式就包含了元数据(用于以后的数据处理)、数据分析(数据处理结果的质量,可编辑性,还有数据运算之类的)以及其他的一些基本操作功能。python的框架基本上也差不多。但是针对数据库的读写等操作,常用的框架都不太一样,比如pymysql就不是通过列表读取,而是通过索引来读取数据库。

而no_boost的boost框架则会非常注重读写的高级功能。类似的,我所知道的目前被广泛使用的python框架的读写模式:boost::read_mysql,这是python中非常常用的一个读写模式,而tornado的使用者则是使用mysqlbuilder这个数据库读写的模块。所以可以看出这样的文档,框架的数据模型并不是必须的,甚至往往可以说,这种框架的封装也是无用的。

我所知道的是一些基于工具链的框架,比如w3cschool的scrapy框架,这是一个非常优秀的框架,一个实验项目就花了一个星期就搞定了python入门教程|菜鸟教程另外就是web服务器(异步或异步),数据库(orm或pydroid)等一些和其他框架一样有优势,但是不利于简单封装python调用工具的功能。

至于html5是否有必要用框架来做相关的操作?这要看你的场景。你如果是一个异步爬虫,并且基本的对象都是其他框架封装的,那么用纯html5框架就行。如果你的对象本身不能用xml或者xhtml封装成对象,那就还是需要做些封装,才能方便调。

网页源代码抓取工具(PHP中嵌入有多种方式,PHP代码输出HTML代码代码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-03-02 10:20

有很多方法可以在 PHP 中嵌入 HTML。这里有几种常见的方式: PHP代码输出HTML代码;PHP嵌入在HTML代码中;PHP使用include()函数引用Html文件php网页教程;示例 HTML 代码 (test.html)

我是一段Html代码

方法一:方法二:修改test.html为test.php文件,直接写PHP代码

我是一段Html代码

注意:如果要输出一大段HTML,请参考以下代码:

我是一段Html代码

注意:标记符号必须写在顶部。方法三:我们直接将HTML代码引用到PHP中。

php获取网页源代码爬取网页内容的几种方法?

1、使用file_get_contents获取网页源代码php网页教程。这种方法是最常用的,只需要两行代码,非常简单方便。

2、使用fopen获取网页源码php网页教程。用这种方法的人很多,但是代码有点多。

3、使用curl获取网页源代码。使用curl获取网页PHP网页教程源码的做法,经常被需要更高要求的人使用。比如在爬取网页内容的同时需要获取网页头信息时,以及使用ENCODING编码、使用USERAGENT等。所谓网页代码,是指在网页创建过程中需要用到的一些特殊的“语言”。设计师组织和安排这些“语言”来创建网页,然后浏览器“翻译”代码。是我们最终看到的。制作网页时常用的代码有HTML、JavaScript、ASP、PHP、CGI等。其中,超文本标记语言(标准通用标记语言下的一种应用, 查看全部

网页源代码抓取工具(PHP中嵌入有多种方式,PHP代码输出HTML代码代码)

有很多方法可以在 PHP 中嵌入 HTML。这里有几种常见的方式: PHP代码输出HTML代码;PHP嵌入在HTML代码中;PHP使用include()函数引用Html文件php网页教程;示例 HTML 代码 (test.html)

我是一段Html代码

方法一:方法二:修改test.html为test.php文件,直接写PHP代码

我是一段Html代码

注意:如果要输出一大段HTML,请参考以下代码:

我是一段Html代码

注意:标记符号必须写在顶部。方法三:我们直接将HTML代码引用到PHP中。

php获取网页源代码爬取网页内容的几种方法?

1、使用file_get_contents获取网页源代码php网页教程。这种方法是最常用的,只需要两行代码,非常简单方便。

2、使用fopen获取网页源码php网页教程。用这种方法的人很多,但是代码有点多。

3、使用curl获取网页源代码。使用curl获取网页PHP网页教程源码的做法,经常被需要更高要求的人使用。比如在爬取网页内容的同时需要获取网页头信息时,以及使用ENCODING编码、使用USERAGENT等。所谓网页代码,是指在网页创建过程中需要用到的一些特殊的“语言”。设计师组织和安排这些“语言”来创建网页,然后浏览器“翻译”代码。是我们最终看到的。制作网页时常用的代码有HTML、JavaScript、ASP、PHP、CGI等。其中,超文本标记语言(标准通用标记语言下的一种应用,

网页源代码抓取工具(本文网络,仅供学习、交流使用不具有任何商业用途,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-03-02 10:14

前言

本文文字和图片来源于网络,仅供学习交流,不做任何商业用途。版权归原作者所有。如有任何问题,请及时联系我们进行处理。

1 提取百度新闻标题、URL、日期和来源1.1 获取网页源代码

我们可以通过以下代码获取网页的源代码。示例中的代码是获取百度新闻搜索阿里巴巴的网页源代码。

1import requests

2

3headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) '

4 'AppleWebKit/537.36 (KHTML, like Gecko) '

5 'Chrome/77.0.3865.120 Safari/537.36'}

6res = requests.get(url, headers=headers)

7web_text = res.text

8

因为百度新闻网站只识别浏览器发送的请求,所以需要设置headers参数来模拟浏览器的发送请求,chrome浏览器可以通过about:version获取。

1.2 编写正则表达式提取新闻信息1.2.1 提取新闻来源和日期

通过查看网页的源代码,我们发现每条新闻的来源和发布日期都夹在中间

和

因此,在这两者之间,可以通过正则表达式获得中间源和日期信息。

1pattern = '<p class="c-author">(.*?)'

2info = re.findall(pattern, web_text, re.S) # re.S用于考虑换行符,因为.和*不包含换行符

3print(info)

4

</p>

获取的信息收录许多字符,例如空格、换行符、制表符和

标签的内容需要清洗两次,后续章节会介绍。

1.2.2 提取新闻的 URL 和标题。

为了提取新闻 URL 和标题,我们需要像上一节一样从网页的源代码中找到规则。通过获取的源码,我们发现新闻地址都在前面。

通过以下两段代码,可以分别获取新闻的URL和标题。

1 pattern_herf = '.*?(.*?)'

6 title = re.findall(pattern_title, web_text, re.S)

7 print(title)

8

获取的数据还需要二次数据清洗。

1.2.3 数据清洗

新闻头条清洗

提取的新闻标题数据存在两个问题:一是每个标题的末尾收录换行符和一些空格;二是中间有和等无效字符。

(1)使用 stip() 函数删除不必要的空格和换行符。

1for i in range(len(title)):

2 title[i] = title[i].strip()

3

2)使用 sub() 函数处理和

1for i in range(len(title)):

2 title[i] = title[i].strip()

3 title[i] = re.sub('', '', title[i])

4

2 新闻来源和日期清理

提取的新闻来源和日期存在的问题:混杂了大量的标签信息;新闻来源和日期链接在一起;混合了许多换行符、制表符、空格等。

1for i inrange(len(info)):2info[i]= re.sub('','', info[i])#清洗

标签信息 3source.append(info[i].split(' ')[0])# 分离新闻来源和日期 4date.append(info[i].split(' ')[1])5source[i]= source [i].strip()6date[i]= date[i].strip()7

2. 批量获取多家公司的百度新闻并生成数据报表

本章主要实现批量获取多家公司信息,并自动生成数据报表,导出为文本文件

2.1 批量抓取多家公司的百度新闻

在这里,我们将爬取网页的工作封装成一个函数。

1defbaidu_news(company):2"""3 获取网页源代码,提取百度新闻标题、URL、日期和来源4 :param company: company name5 :return: 网页源代码6 """7 url ='# x27;+ company8#百度新闻网站只识别浏览器发送的请求,所以需要设置headers参数,9#模拟浏览器发送的请求,chrome浏览器可以获得10个headers ={ 'User-Agent through about:version ':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) '11'AppleWebKit/537.36 (KHTML,如 Gecko)'12 'Chrome/77.0.3865.120 Safari/537.36'}13 res = requests.get(url, headers =headers)14 web_text = res.text1516#获取新闻17模式的来源和日期='

(.*?)

'18 info = re.findall(pattern, web_text, re.S)# re.S 用于说明换行符,因为 . and * 不收录换行符 19# print(info)2021# 获取新闻的url和标题 22 pattern_herf ='.*?23 herf = re.findall(pattern_herf, web_text, re.S)24# print(herf) 2526 pattern_title ='.*?>(.*?)'27 title = re.findall(pattern_title, web_text , re.S)28# print(title)2930# 标题数据清洗 31for i inrange(len(title)): 32title[i]= title[i].strip()33title[i]= re.sub('' ,'', title[i])3435# print(title)3637# 新闻来源和日期清洗 38 source =[ ]39 date =[]4041for i inrange(len(info)):42info[i]= re.sub('','', info[i])#清洗

标签信息 43source.append(info[i].split(' ')[0])# 分开消息源和日期 44date.append(info[i].split(' ')[1])45source[i]= source [i].strip()46date[i]= date[i].strip()4748print(str(i+1)+'.'+ title[i]+'('+ date[i]+ ' -'+来源[i]+')')49

然后在main函数中编写调用过程。

1 companys = ['华能信托', '腾讯', '阿里巴巴']

2 for company in companys:

3 baidu_news(company)

4 print(company + '百度新闻爬取成功')

5

结果如下所示:

11.信托业绩哪家强?两家去年净利超30亿 华宸华融有点“惨淡”(2020年01月21日 23:38-每日经济新闻)

22.57家信托业绩哪家强?中信、华能、重庆信托稳坐前三(2020年01月20日 07:47-新浪财经)

33.2019年净利润排位确定:中信信托35.93亿独占鳌头(2020年01月16日 16:51-金融界)

44.关于为“华能信托-链融科技诚意2期供应链金融资产支持专项计划”...(2020年01月16日 23:10-金融界)

55.2019信托公司业绩哪家强?(2020年01月17日 19:53-中国金融新闻网)

66.去年信托调研185家上市公司 电子设备制造业成为重点(2020年01月06日 10:07-中国基金会网)

77.关于为“华能信托-一方诚意3期供应链金融资产支持专项计划”提供...(2020年01月06日 23:10-新浪)

88.牧原股份联合华能信托 拟72亿元设立两家养猪子公司(2019年12月11日 22:28-同花顺财经)

99.牧原股份生猪养殖多地开花 借力华能信托找钱(2019年12月11日 10:32-财新)

1010.牧原股份(002714.SZ)与华能贵诚信托设立的合资公司已注册成立(2019年12月12日 21:09-新浪)

11华能信托百度新闻爬取成功

121.广东首例N95口罩诈骗案告破 腾讯协助警方破案(1小时前-中国新闻网)

132.抗击疫情 腾讯联合微医等五平台提供义诊服务(1小时前-新浪)

143.腾讯联合五大平台,在线义诊新型肺炎(1小时前-手机凤凰网)

154.腾讯文档开放免费会员,全面支持远程办公(4小时前-新浪)

165.最惨游戏工作室!13年9款神作却穷得叮当响,腾讯看中后出手了(1小时前-17173游戏网)

176.音乐战“疫”进行时 TME腾讯音乐人踊跃创作公益歌曲“声”援武汉(54分钟前-腾讯科技)

187.如果说国行NS不是腾讯和任天堂合作的重点,那什么是重点?(1小时前-新浪)

198.腾讯云向黄牛教授实验室,罗海彬教授团队提供免费云超算等(23分钟前-钛媒体)

209.停课不停学 腾讯课堂助力重庆十一中高三线下课首次线上开课(6小时前-环球网)

2110.腾讯文档开放免费会员功能 协同编辑人数至200人(50分钟前-中关村在线)

22腾讯百度新闻爬取成功

231.阿里巴巴全球14国直采医疗物资驰援,将通过东方航空陆续抵汉(39分钟前-武汉发布)

242.阿里巴巴全球采购医疗物资 首批N95口罩今日运抵武汉(29分钟前-浙江新闻)

253.阿里巴巴与东航合力 在14国采购与运输医疗物资(1小时前-新浪)

264.阿里巴巴全球采购医疗物资陆续抵沪(48分钟前-同花顺财经)

275.阿里巴巴一纸“禁令”后,商家祭出高仿口罩!抓住这点、一招鉴别(9分钟前-IT爆料王)

286.阿里巴巴等百家企业承诺:防疫、民生用品价格不涨(6小时前-TechWeb)

297.【阿里巴巴等多个企业共同发出“三保行动 让我们一起出发”的倡议】(5小时前-新浪)

308.阿里巴巴上线发热门诊查询 已覆盖5734个发热门诊(2020年01月29日 11:10-中国新闻网)

319.武汉疫情口罩脱销,阿里巴巴发出紧急通知,这种口罩不能买!(1小时前-科技季节)

3210.阿里巴巴等多家企业响应市场监管总局“三保”行动(2020年01月29日 23:47-新浪财经)

33阿里巴巴百度新闻爬取成功

34

2.2 自动生成舆情数据报告文本文件

在上一节中,我们已经爬取了我们想要的新闻并生成了舆情结果,将导出到下面的文本文件中。

baidu_news()函数后添加导出到文件的相关操作代码如下:

1 file_ = open('数据挖掘报告.txt', 'a') #追加模式,不清除原来的数据

2 file_.write(company + '新闻数据:' + '\n' + '\n')

3 for i in range(len(title)):

4 file_.write(str(i+1) + '.' + title[i] + '(' + date[i] + '-' + source[i] + ')' + '\n')

5 file_.write(href[i] + '\n')

6

7 file_.write('————————————————————————————————————————————' + '\n' + '\n')

8 file_.close()

9

3.异常处理与24小时实时数据挖掘实践3.1异常处理

这里,执行baidu_news()函数需要异常处理。

1 companys = ['华能信托', '腾讯', '阿里巴巴']

2 for company in companys:

3 try:

4 baidu_news(company)

5 print(company + '百度新闻爬取成功!')

6 except:

7 print(company + '百度新闻爬取失败!')

8

3.2 24小时实时爬取

这个函数的实现比较简单。您只需要在程序外部放置一个 while True 循环。然后,每次循环执行后,可以参考时间库,执行time.sleep()函数,让程序定时执行。.

通过前面的代码,我们已经可以实现24小时不间断的获取新闻内容,但是难免会抓取重复的新闻数据,这涉及到数据去重的内容,需要用到数据库的相关知识. 这部分内容将在后续章节中介绍,感兴趣的读者可以继续关注。

4. 按时间顺序爬取并批量爬取多页内容

前几章只爬取了百度新闻搜索结果首页的内容,新闻数据并不全面。本章将介绍批量爬取多页内容的方法。

4.1 按时间顺序爬取百度新闻

这里不涉及代码修改的内容,因为百度新闻默认按照“焦点顺序”排列新闻内容。这里我们可以选择搜索结果页面右上角的“按时间排序”按钮,然后修改url。

4.2 一次批量爬取多页内容

如果我们要爬取多页内容,我们需要分析每个页面的URL的差异。

第一个页面内容的 URL 是:

1https://www.baidu.com/s%3Ftn%3 ... wd%3D阿里巴巴

2

第二页内容的网址是

1https://www.baidu.com/s%3Ftn%3 ... wd%3D阿里巴巴&pn=10

2

第二页内容的 URL 是 .

1https://www.baidu.com/s%3Ftn%3 ... wd%3D阿里巴巴&pn=20

2

通过对比可以发现,页面URL的区别是&pn=XX。这里,可以确定可以在第一页的URL之后添加内容&pn=0。因此,代码可以修改如下。

1def baidu_news(company, page):

2 """

3 获取网页源码,并提取百度新闻标题、网址、日期和来源

4 :param company: 公司名称

5 :param page: 需要爬取的页面的数量

6 :return: 网页源码

7 """

8 num = (page - 1) * 10

9

10 url = 'https://www.baidu.com/s%3Frtt% ... 27%3B + company + '&pn=' + str(num)

11

12 res = requests.get(url, headers=headers, timeout=10)

13 web_text = res.text

14 # 此处省略了数据提取、清洗和爬取的代码

15

16def main():

17 companys = ['华能信托', '腾讯', '阿里巴巴']

18 for company in companys:

19 for i in range(5): # 爬取5页内容

20 try:

21 baidu_news(company, i+1)

22 print(company + str(i+1) + '页新闻爬取成功!')

23 except:

24 print(company + str(i+1) + '页新闻爬取失败!')

25

5.搜狗新闻与新浪财经数据挖掘实践

这里采用的方法类似于爬取百度新闻的方法。

5.1 搜狗新闻数据爬取

首先,获取搜狗新闻的网址,我们在搜狗新闻中搜索“阿里巴巴”,得到网址(删除后):

阿里巴巴

完整代码如下:

1"""

2 作者:Aidan

3 时间:30/01/2020

4 功能:爬取搜狗新闻数据

5"""

6

7import requests

8import re

9

10# 百度新闻网站只认可浏览器发送的请求,所以需要设置headers参数,

11# 以模拟浏览器的发送请求,chrome浏览器可以通过about:version获取

12headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) '

13 'AppleWebKit/537.36 (KHTML, like Gecko) '

14 'Chrome/77.0.3865.120 Safari/537.36'}

15

16def sougou_news(company, page):

17 """

18 获取网页源码,并提取搜狗新闻标题、网址、日期和来源

19 :param company: 公司名称

20 :param page: 需要爬取的页面的数量

21 :return: 网页源码

22 """

23

24 url = 'https://news.sogou.com/news?query=' + company + '&page=' + str(page)

25

26 res = requests.get(url, headers=headers, timeout=10) # 当访问网址10秒没有响应时,就会停止访问。timeout=10

27 web_text = res.text

28

29 # 获取新闻日期

30 pattern_date = '<p class="news-from">.*? (.*?)'

31 date = re.findall(pattern_date, web_text, re.S) # re.S用于考虑换行符,因为.和*不包含换行符

32 # print(info)

33

34 # 获取新闻的网址和标题

35 pattern_herf = '.*?(.*?)'

40 title = re.findall(pattern_title, web_text, re.S)

41 # print(title)

42

43 # 数据清洗

44 for i in range(len(title)):

45 title[i] = re.sub('', '', title[i])

46 title[i] = re.sub('&.*?;', '', title[i])

47 date[i] = re.sub('', '', date[i])

48

49 file_ = open('搜狗数据挖掘报告.txt', 'a') #追加模式,不清除原来的数据

50 file_.write(company + str(i+1) + '页新闻数据:' + '\n' + '\n')

51 for i in range(len(title)):

52 file_.write(str(i+1) + '.' + title[i] + '(' + date[i] + ')' + '\n')

53 file_.write(href[i] + '\n')

54

55 file_.write('————————————————————————————————————————————' + '\n' + '\n')

56 file_.close()

57

58def main():

59 companys = ['华能信托', '腾讯', '阿里巴巴']

60 for company in companys:

61 for i in range(5): # 爬取5页内容

62 try:

63 sougou_news(company, i+1)

64 print(company + str(i+1) + '页新闻爬取成功!')

65 except:

66 print(company + str(i+1) + '页新闻爬取失败!')

67

68if __name__ == '__main__':

69 main()

70

</p>

欢迎点击左上角关注小编,除了分享技术文章还有很多福利,私信学习资料可领取,包括但不限于Python实战演练、PDF电子文档、面试亮点、学习资料等 查看全部

网页源代码抓取工具(本文网络,仅供学习、交流使用不具有任何商业用途,)

前言

本文文字和图片来源于网络,仅供学习交流,不做任何商业用途。版权归原作者所有。如有任何问题,请及时联系我们进行处理。

1 提取百度新闻标题、URL、日期和来源1.1 获取网页源代码

我们可以通过以下代码获取网页的源代码。示例中的代码是获取百度新闻搜索阿里巴巴的网页源代码。

1import requests

2

3headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) '

4 'AppleWebKit/537.36 (KHTML, like Gecko) '

5 'Chrome/77.0.3865.120 Safari/537.36'}

6res = requests.get(url, headers=headers)

7web_text = res.text

8

因为百度新闻网站只识别浏览器发送的请求,所以需要设置headers参数来模拟浏览器的发送请求,chrome浏览器可以通过about:version获取。

1.2 编写正则表达式提取新闻信息1.2.1 提取新闻来源和日期

通过查看网页的源代码,我们发现每条新闻的来源和发布日期都夹在中间

和

因此,在这两者之间,可以通过正则表达式获得中间源和日期信息。

1pattern = '<p class="c-author">(.*?)'

2info = re.findall(pattern, web_text, re.S) # re.S用于考虑换行符,因为.和*不包含换行符

3print(info)

4

</p>

获取的信息收录许多字符,例如空格、换行符、制表符和

标签的内容需要清洗两次,后续章节会介绍。

1.2.2 提取新闻的 URL 和标题。

为了提取新闻 URL 和标题,我们需要像上一节一样从网页的源代码中找到规则。通过获取的源码,我们发现新闻地址都在前面。

通过以下两段代码,可以分别获取新闻的URL和标题。

1 pattern_herf = '.*?(.*?)'

6 title = re.findall(pattern_title, web_text, re.S)

7 print(title)

8

获取的数据还需要二次数据清洗。

1.2.3 数据清洗

新闻头条清洗

提取的新闻标题数据存在两个问题:一是每个标题的末尾收录换行符和一些空格;二是中间有和等无效字符。

(1)使用 stip() 函数删除不必要的空格和换行符。

1for i in range(len(title)):

2 title[i] = title[i].strip()

3

2)使用 sub() 函数处理和

1for i in range(len(title)):

2 title[i] = title[i].strip()

3 title[i] = re.sub('', '', title[i])

4

2 新闻来源和日期清理

提取的新闻来源和日期存在的问题:混杂了大量的标签信息;新闻来源和日期链接在一起;混合了许多换行符、制表符、空格等。

1for i inrange(len(info)):2info[i]= re.sub('','', info[i])#清洗

标签信息 3source.append(info[i].split(' ')[0])# 分离新闻来源和日期 4date.append(info[i].split(' ')[1])5source[i]= source [i].strip()6date[i]= date[i].strip()7

2. 批量获取多家公司的百度新闻并生成数据报表

本章主要实现批量获取多家公司信息,并自动生成数据报表,导出为文本文件

2.1 批量抓取多家公司的百度新闻

在这里,我们将爬取网页的工作封装成一个函数。

1defbaidu_news(company):2"""3 获取网页源代码,提取百度新闻标题、URL、日期和来源4 :param company: company name5 :return: 网页源代码6 """7 url ='# x27;+ company8#百度新闻网站只识别浏览器发送的请求,所以需要设置headers参数,9#模拟浏览器发送的请求,chrome浏览器可以获得10个headers ={ 'User-Agent through about:version ':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) '11'AppleWebKit/537.36 (KHTML,如 Gecko)'12 'Chrome/77.0.3865.120 Safari/537.36'}13 res = requests.get(url, headers =headers)14 web_text = res.text1516#获取新闻17模式的来源和日期='

(.*?)

'18 info = re.findall(pattern, web_text, re.S)# re.S 用于说明换行符,因为 . and * 不收录换行符 19# print(info)2021# 获取新闻的url和标题 22 pattern_herf ='.*?23 herf = re.findall(pattern_herf, web_text, re.S)24# print(herf) 2526 pattern_title ='.*?>(.*?)'27 title = re.findall(pattern_title, web_text , re.S)28# print(title)2930# 标题数据清洗 31for i inrange(len(title)): 32title[i]= title[i].strip()33title[i]= re.sub('' ,'', title[i])3435# print(title)3637# 新闻来源和日期清洗 38 source =[ ]39 date =[]4041for i inrange(len(info)):42info[i]= re.sub('','', info[i])#清洗

标签信息 43source.append(info[i].split(' ')[0])# 分开消息源和日期 44date.append(info[i].split(' ')[1])45source[i]= source [i].strip()46date[i]= date[i].strip()4748print(str(i+1)+'.'+ title[i]+'('+ date[i]+ ' -'+来源[i]+')')49

然后在main函数中编写调用过程。

1 companys = ['华能信托', '腾讯', '阿里巴巴']

2 for company in companys:

3 baidu_news(company)

4 print(company + '百度新闻爬取成功')

5

结果如下所示:

11.信托业绩哪家强?两家去年净利超30亿 华宸华融有点“惨淡”(2020年01月21日 23:38-每日经济新闻)

22.57家信托业绩哪家强?中信、华能、重庆信托稳坐前三(2020年01月20日 07:47-新浪财经)

33.2019年净利润排位确定:中信信托35.93亿独占鳌头(2020年01月16日 16:51-金融界)

44.关于为“华能信托-链融科技诚意2期供应链金融资产支持专项计划”...(2020年01月16日 23:10-金融界)

55.2019信托公司业绩哪家强?(2020年01月17日 19:53-中国金融新闻网)

66.去年信托调研185家上市公司 电子设备制造业成为重点(2020年01月06日 10:07-中国基金会网)

77.关于为“华能信托-一方诚意3期供应链金融资产支持专项计划”提供...(2020年01月06日 23:10-新浪)

88.牧原股份联合华能信托 拟72亿元设立两家养猪子公司(2019年12月11日 22:28-同花顺财经)

99.牧原股份生猪养殖多地开花 借力华能信托找钱(2019年12月11日 10:32-财新)

1010.牧原股份(002714.SZ)与华能贵诚信托设立的合资公司已注册成立(2019年12月12日 21:09-新浪)

11华能信托百度新闻爬取成功

121.广东首例N95口罩诈骗案告破 腾讯协助警方破案(1小时前-中国新闻网)

132.抗击疫情 腾讯联合微医等五平台提供义诊服务(1小时前-新浪)

143.腾讯联合五大平台,在线义诊新型肺炎(1小时前-手机凤凰网)

154.腾讯文档开放免费会员,全面支持远程办公(4小时前-新浪)

165.最惨游戏工作室!13年9款神作却穷得叮当响,腾讯看中后出手了(1小时前-17173游戏网)

176.音乐战“疫”进行时 TME腾讯音乐人踊跃创作公益歌曲“声”援武汉(54分钟前-腾讯科技)

187.如果说国行NS不是腾讯和任天堂合作的重点,那什么是重点?(1小时前-新浪)

198.腾讯云向黄牛教授实验室,罗海彬教授团队提供免费云超算等(23分钟前-钛媒体)

209.停课不停学 腾讯课堂助力重庆十一中高三线下课首次线上开课(6小时前-环球网)

2110.腾讯文档开放免费会员功能 协同编辑人数至200人(50分钟前-中关村在线)

22腾讯百度新闻爬取成功

231.阿里巴巴全球14国直采医疗物资驰援,将通过东方航空陆续抵汉(39分钟前-武汉发布)

242.阿里巴巴全球采购医疗物资 首批N95口罩今日运抵武汉(29分钟前-浙江新闻)

253.阿里巴巴与东航合力 在14国采购与运输医疗物资(1小时前-新浪)

264.阿里巴巴全球采购医疗物资陆续抵沪(48分钟前-同花顺财经)

275.阿里巴巴一纸“禁令”后,商家祭出高仿口罩!抓住这点、一招鉴别(9分钟前-IT爆料王)

286.阿里巴巴等百家企业承诺:防疫、民生用品价格不涨(6小时前-TechWeb)

297.【阿里巴巴等多个企业共同发出“三保行动 让我们一起出发”的倡议】(5小时前-新浪)

308.阿里巴巴上线发热门诊查询 已覆盖5734个发热门诊(2020年01月29日 11:10-中国新闻网)

319.武汉疫情口罩脱销,阿里巴巴发出紧急通知,这种口罩不能买!(1小时前-科技季节)

3210.阿里巴巴等多家企业响应市场监管总局“三保”行动(2020年01月29日 23:47-新浪财经)

33阿里巴巴百度新闻爬取成功

34

2.2 自动生成舆情数据报告文本文件

在上一节中,我们已经爬取了我们想要的新闻并生成了舆情结果,将导出到下面的文本文件中。

baidu_news()函数后添加导出到文件的相关操作代码如下:

1 file_ = open('数据挖掘报告.txt', 'a') #追加模式,不清除原来的数据

2 file_.write(company + '新闻数据:' + '\n' + '\n')

3 for i in range(len(title)):

4 file_.write(str(i+1) + '.' + title[i] + '(' + date[i] + '-' + source[i] + ')' + '\n')

5 file_.write(href[i] + '\n')

6

7 file_.write('————————————————————————————————————————————' + '\n' + '\n')

8 file_.close()

9

3.异常处理与24小时实时数据挖掘实践3.1异常处理

这里,执行baidu_news()函数需要异常处理。

1 companys = ['华能信托', '腾讯', '阿里巴巴']

2 for company in companys:

3 try:

4 baidu_news(company)

5 print(company + '百度新闻爬取成功!')

6 except:

7 print(company + '百度新闻爬取失败!')

8

3.2 24小时实时爬取

这个函数的实现比较简单。您只需要在程序外部放置一个 while True 循环。然后,每次循环执行后,可以参考时间库,执行time.sleep()函数,让程序定时执行。.

通过前面的代码,我们已经可以实现24小时不间断的获取新闻内容,但是难免会抓取重复的新闻数据,这涉及到数据去重的内容,需要用到数据库的相关知识. 这部分内容将在后续章节中介绍,感兴趣的读者可以继续关注。

4. 按时间顺序爬取并批量爬取多页内容

前几章只爬取了百度新闻搜索结果首页的内容,新闻数据并不全面。本章将介绍批量爬取多页内容的方法。

4.1 按时间顺序爬取百度新闻

这里不涉及代码修改的内容,因为百度新闻默认按照“焦点顺序”排列新闻内容。这里我们可以选择搜索结果页面右上角的“按时间排序”按钮,然后修改url。

4.2 一次批量爬取多页内容

如果我们要爬取多页内容,我们需要分析每个页面的URL的差异。

第一个页面内容的 URL 是:

1https://www.baidu.com/s%3Ftn%3 ... wd%3D阿里巴巴

2

第二页内容的网址是

1https://www.baidu.com/s%3Ftn%3 ... wd%3D阿里巴巴&pn=10

2

第二页内容的 URL 是 .

1https://www.baidu.com/s%3Ftn%3 ... wd%3D阿里巴巴&pn=20

2

通过对比可以发现,页面URL的区别是&pn=XX。这里,可以确定可以在第一页的URL之后添加内容&pn=0。因此,代码可以修改如下。

1def baidu_news(company, page):

2 """

3 获取网页源码,并提取百度新闻标题、网址、日期和来源

4 :param company: 公司名称

5 :param page: 需要爬取的页面的数量

6 :return: 网页源码

7 """

8 num = (page - 1) * 10

9

10 url = 'https://www.baidu.com/s%3Frtt% ... 27%3B + company + '&pn=' + str(num)

11

12 res = requests.get(url, headers=headers, timeout=10)

13 web_text = res.text

14 # 此处省略了数据提取、清洗和爬取的代码

15

16def main():

17 companys = ['华能信托', '腾讯', '阿里巴巴']

18 for company in companys:

19 for i in range(5): # 爬取5页内容

20 try:

21 baidu_news(company, i+1)

22 print(company + str(i+1) + '页新闻爬取成功!')

23 except:

24 print(company + str(i+1) + '页新闻爬取失败!')

25

5.搜狗新闻与新浪财经数据挖掘实践

这里采用的方法类似于爬取百度新闻的方法。

5.1 搜狗新闻数据爬取

首先,获取搜狗新闻的网址,我们在搜狗新闻中搜索“阿里巴巴”,得到网址(删除后):

阿里巴巴

完整代码如下:

1"""

2 作者:Aidan

3 时间:30/01/2020

4 功能:爬取搜狗新闻数据

5"""

6

7import requests

8import re

9

10# 百度新闻网站只认可浏览器发送的请求,所以需要设置headers参数,

11# 以模拟浏览器的发送请求,chrome浏览器可以通过about:version获取

12headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) '

13 'AppleWebKit/537.36 (KHTML, like Gecko) '

14 'Chrome/77.0.3865.120 Safari/537.36'}

15

16def sougou_news(company, page):

17 """

18 获取网页源码,并提取搜狗新闻标题、网址、日期和来源

19 :param company: 公司名称

20 :param page: 需要爬取的页面的数量

21 :return: 网页源码

22 """

23

24 url = 'https://news.sogou.com/news?query=' + company + '&page=' + str(page)

25

26 res = requests.get(url, headers=headers, timeout=10) # 当访问网址10秒没有响应时,就会停止访问。timeout=10

27 web_text = res.text

28

29 # 获取新闻日期

30 pattern_date = '<p class="news-from">.*? (.*?)'

31 date = re.findall(pattern_date, web_text, re.S) # re.S用于考虑换行符,因为.和*不包含换行符

32 # print(info)

33

34 # 获取新闻的网址和标题

35 pattern_herf = '.*?(.*?)'

40 title = re.findall(pattern_title, web_text, re.S)

41 # print(title)

42

43 # 数据清洗

44 for i in range(len(title)):

45 title[i] = re.sub('', '', title[i])

46 title[i] = re.sub('&.*?;', '', title[i])

47 date[i] = re.sub('', '', date[i])

48

49 file_ = open('搜狗数据挖掘报告.txt', 'a') #追加模式,不清除原来的数据

50 file_.write(company + str(i+1) + '页新闻数据:' + '\n' + '\n')

51 for i in range(len(title)):

52 file_.write(str(i+1) + '.' + title[i] + '(' + date[i] + ')' + '\n')

53 file_.write(href[i] + '\n')

54

55 file_.write('————————————————————————————————————————————' + '\n' + '\n')

56 file_.close()

57

58def main():

59 companys = ['华能信托', '腾讯', '阿里巴巴']

60 for company in companys:

61 for i in range(5): # 爬取5页内容

62 try:

63 sougou_news(company, i+1)

64 print(company + str(i+1) + '页新闻爬取成功!')

65 except:

66 print(company + str(i+1) + '页新闻爬取失败!')

67

68if __name__ == '__main__':

69 main()

70

</p>

欢迎点击左上角关注小编,除了分享技术文章还有很多福利,私信学习资料可领取,包括但不限于Python实战演练、PDF电子文档、面试亮点、学习资料等

网页源代码抓取工具(任选一处供爬虫爬取源码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-03-02 10:13

包裹的块级结构,这个结构有class关键字,class值为“neir_neir”。我们并不完全理解这些代码的含义。但是我们知道,有了这些唯一的关键字,我们就可以在源代码中找到这个位置,进一步定位到想要的信息。扩张

结构,我们看到如下源码:

惊喜!我们没有找到页面显示的公司名称,就在

在标签后面发现了一条注释(浏览器不解析,仅供人类阅读,格式为 )。公司名称存储在此注释中。可以猜到href(这个关键字后引出一个URL——universal resource locator,统一资源定位器,俗称URL)一定会引到公司的页面。

网址。访问网址后(添加如图所示的网址后合成)发现确实如此,我们来到了公司页面的首页。

我们想进一步了解公司的介绍页面。点击公司介绍,我们跳转到介绍页面,发现公司介绍页面网址是。URL 中只有一项 shopname=FS。这样我们就可以看到公司介绍页面URL的命名规则了。公司介绍页面的URL为公司代码/介绍,公司代码为评论中URL中shopname关键字后引导的内容。

当然,即使没有这个注释,我们仍然可以找到我们需要的资源。由于我们在网页上看到了公司的名称,并且可以通过点击超链接跳转到公司的页面,这意味着公司的名称和公司页面的URL必须记录在某个地方。因为评论中的内容没有被浏览器解析,所以我们在网页中看到的不可能是评论中的内容。

阅读源代码,发现信息存储在注释下方内联元素的超链接中(不需要专有名词)。href给出了公司页面URL,汉字明显是公司名称。我们需要的信息存储在两个不同的位置,我们可以选择一个供爬虫爬取。

我们已经到了公司介绍页面,通过箭头工具,我们可以在源代码中找到如上所示的公司介绍文字。解析 HTML 中的信息总是非常简单的。定位如下:

介绍信息收录在

之中。(这里有个坑,后面的公司介绍信息不都是这种形式的,有的直接包裹在

中间。这就需要我们根据情况进行调试。)

这样,我们就彻底完成了黄页第一个公司名称的定位和介绍信息的定位。之后查看公司,发现每个公司都有相同的 HTML 结构。这很容易想到,每个公司在网页上似乎都有相同的结构,源代码也必须有规律性。这样,我们就弄清楚了如何找到一家公司的名称和介绍页面,而且查找其他公司的信息也没有问题。

最后,即使我们没有编程基础,像天书一样阅读HTML源代码,我们也可以使用开发者工具的箭头工具来定位网页元素在源代码中的位置,并阅读源代码找到我们想要的信息。确定这个信息的位置,找到我们要爬取的信息的存储规则,分析HTML,即使成功完成。

(待续)

爬虫作为企业黄页的例子 查看全部

网页源代码抓取工具(任选一处供爬虫爬取源码)

包裹的块级结构,这个结构有class关键字,class值为“neir_neir”。我们并不完全理解这些代码的含义。但是我们知道,有了这些唯一的关键字,我们就可以在源代码中找到这个位置,进一步定位到想要的信息。扩张

结构,我们看到如下源码:

惊喜!我们没有找到页面显示的公司名称,就在

在标签后面发现了一条注释(浏览器不解析,仅供人类阅读,格式为 )。公司名称存储在此注释中。可以猜到href(这个关键字后引出一个URL——universal resource locator,统一资源定位器,俗称URL)一定会引到公司的页面。

网址。访问网址后(添加如图所示的网址后合成)发现确实如此,我们来到了公司页面的首页。

我们想进一步了解公司的介绍页面。点击公司介绍,我们跳转到介绍页面,发现公司介绍页面网址是。URL 中只有一项 shopname=FS。这样我们就可以看到公司介绍页面URL的命名规则了。公司介绍页面的URL为公司代码/介绍,公司代码为评论中URL中shopname关键字后引导的内容。

当然,即使没有这个注释,我们仍然可以找到我们需要的资源。由于我们在网页上看到了公司的名称,并且可以通过点击超链接跳转到公司的页面,这意味着公司的名称和公司页面的URL必须记录在某个地方。因为评论中的内容没有被浏览器解析,所以我们在网页中看到的不可能是评论中的内容。

阅读源代码,发现信息存储在注释下方内联元素的超链接中(不需要专有名词)。href给出了公司页面URL,汉字明显是公司名称。我们需要的信息存储在两个不同的位置,我们可以选择一个供爬虫爬取。

我们已经到了公司介绍页面,通过箭头工具,我们可以在源代码中找到如上所示的公司介绍文字。解析 HTML 中的信息总是非常简单的。定位如下:

介绍信息收录在

之中。(这里有个坑,后面的公司介绍信息不都是这种形式的,有的直接包裹在

中间。这就需要我们根据情况进行调试。)

这样,我们就彻底完成了黄页第一个公司名称的定位和介绍信息的定位。之后查看公司,发现每个公司都有相同的 HTML 结构。这很容易想到,每个公司在网页上似乎都有相同的结构,源代码也必须有规律性。这样,我们就弄清楚了如何找到一家公司的名称和介绍页面,而且查找其他公司的信息也没有问题。

最后,即使我们没有编程基础,像天书一样阅读HTML源代码,我们也可以使用开发者工具的箭头工具来定位网页元素在源代码中的位置,并阅读源代码找到我们想要的信息。确定这个信息的位置,找到我们要爬取的信息的存储规则,分析HTML,即使成功完成。

(待续)

爬虫作为企业黄页的例子

网页源代码抓取工具(浅谈网页源代码抓取工具的缺点及应用技巧!(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-02-24 05:04

网页源代码抓取工具作为一个chrome的开发人员,在开发新的,或者从chrome5.0之后推出的开发人员工具的时候,我会考虑升级浏览器版本,比如已经升级到firefox3.0,chrome3.1,chrome3.2或者某些版本。如果是从firefox5.0推出的工具,我会不考虑升级,如果是从chrome5.1之后推出的工具,要么直接加上ccftools(i5,i7之类的),要么再刷新一下源代码抓取页面,一般默认到chrome2012。

一般来说,都是从开发人员工具开始,从最新版本开始,这个可以得到比较直观的演示。作为测试人员,有些公司也会推出一些工具,但大多数不是用的开发人员工具,而是直接从网页抓取,然后再生成js文件发送给后端做一些定制的优化,那些工具都比较类似,我介绍一下f5大法的缺点。一个开发人员工具,最主要的目的是生成js文件(browserjs)。

不是原生的javascript,所以在在启动时会特别慢,或者效率很低,等等。为了兼容旧版本,一般会在headfilter中强制生成老版本的source,如果有其他依赖库就会立即执行,不会引入jquery等css资源,不会生成任何关于功能的字符串,不会有语法校验等功能。第二个缺点,f5会绑定主页和页面地址的路径,但通常是自己生成的,不是浏览器内部的路径,比如知乎的路径,谷歌搜索会有偏差。

这样做,导致后端部分改动如果不牵涉到后端代码逻辑,动态页面依然保持后端代码逻辑完整。如果要去掉后端逻辑,就需要把前端页面爬取下来,然后转换成json或者newjson,然后合并,反正很复杂。第三个缺点是,通常,一个f5会启动很多f5,比如需要启动2万个f5才能不错,而通常为了实现的灵活性,只能启动很少的f5。

为什么没有f5的无敌版本,因为历史。f5毕竟是基于firefox的渲染引擎制作,因此有非常多的机制在中间转换,效率肯定不如firefox,更别说是webkit下,了。f5在启动启动的时候,爬取还是会从开发人员工具启动,所以经常有启动失败,一般能开一些简单的插件,至少可以比较大限度减少启动失败次数。但这点来说,不如webkit版本的方便。

其实一些webkit版本的浏览器,js本身是支持f5的,只不过f5启动会比较慢,有些可以在内核里启动,但有些只能通过外部启动,你可以去试试。至于另外一些,比如webkit浏览器版本对于某些组件未在f5中引入,或者某些页面存在直接html上的依赖,f5和页面本身有可能相冲突。f5的配置说到这,没什么配置的可言,就是改headfilter,source,所以即使一些大网站,都不需要修改headfilter,source也。 查看全部

网页源代码抓取工具(浅谈网页源代码抓取工具的缺点及应用技巧!(一))

网页源代码抓取工具作为一个chrome的开发人员,在开发新的,或者从chrome5.0之后推出的开发人员工具的时候,我会考虑升级浏览器版本,比如已经升级到firefox3.0,chrome3.1,chrome3.2或者某些版本。如果是从firefox5.0推出的工具,我会不考虑升级,如果是从chrome5.1之后推出的工具,要么直接加上ccftools(i5,i7之类的),要么再刷新一下源代码抓取页面,一般默认到chrome2012。

一般来说,都是从开发人员工具开始,从最新版本开始,这个可以得到比较直观的演示。作为测试人员,有些公司也会推出一些工具,但大多数不是用的开发人员工具,而是直接从网页抓取,然后再生成js文件发送给后端做一些定制的优化,那些工具都比较类似,我介绍一下f5大法的缺点。一个开发人员工具,最主要的目的是生成js文件(browserjs)。

不是原生的javascript,所以在在启动时会特别慢,或者效率很低,等等。为了兼容旧版本,一般会在headfilter中强制生成老版本的source,如果有其他依赖库就会立即执行,不会引入jquery等css资源,不会生成任何关于功能的字符串,不会有语法校验等功能。第二个缺点,f5会绑定主页和页面地址的路径,但通常是自己生成的,不是浏览器内部的路径,比如知乎的路径,谷歌搜索会有偏差。

这样做,导致后端部分改动如果不牵涉到后端代码逻辑,动态页面依然保持后端代码逻辑完整。如果要去掉后端逻辑,就需要把前端页面爬取下来,然后转换成json或者newjson,然后合并,反正很复杂。第三个缺点是,通常,一个f5会启动很多f5,比如需要启动2万个f5才能不错,而通常为了实现的灵活性,只能启动很少的f5。

为什么没有f5的无敌版本,因为历史。f5毕竟是基于firefox的渲染引擎制作,因此有非常多的机制在中间转换,效率肯定不如firefox,更别说是webkit下,了。f5在启动启动的时候,爬取还是会从开发人员工具启动,所以经常有启动失败,一般能开一些简单的插件,至少可以比较大限度减少启动失败次数。但这点来说,不如webkit版本的方便。

其实一些webkit版本的浏览器,js本身是支持f5的,只不过f5启动会比较慢,有些可以在内核里启动,但有些只能通过外部启动,你可以去试试。至于另外一些,比如webkit浏览器版本对于某些组件未在f5中引入,或者某些页面存在直接html上的依赖,f5和页面本身有可能相冲突。f5的配置说到这,没什么配置的可言,就是改headfilter,source,所以即使一些大网站,都不需要修改headfilter,source也。

网页源代码抓取工具(从百度地图抓取某个区域边缘坐标点的爬虫程序用到)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-02-23 06:10

之前有两篇文章介绍了一个小python爬虫,也给出了源码;

1. Python | 一个小爬虫(上图)(标题太平淡,这种套路后面也没用,因为太标新立异了)

相信喜欢做的粉丝已经在自己的电脑上运行过这个程序了。但是对于刚接触python的人来说,启动一个python爬虫确实会让自己一头雾水,但是如果我们一直写那种基于知识的文章,你也会觉得只有知识点是不会上瘾的。综合考虑后,我还是觉得这种case还是不错的,即使需要多写几篇文章把一个case解释清楚。

没有看过前两篇文章的同学,建议点进去阅读,了解这篇文章的内容。

前面有点废话,说正经的,这个用来从百度地图抓取某个区域的边缘坐标的爬虫程序用到了哪些知识点和技术?我把它们都列出来:

1.需要对网页结构有基本的了解和认识。

我们通常在互联网上浏览网页,信息是在浏览器中显示在页面上的,但是我们使用爬虫抓取的信息是放在网页的源代码中的。(图1是我们看到的页面,图2是页面对应的网页源代码)

图1 人们浏览网页时看到的界面

图2 网页对应的网页源代码

在浏览器中使用快捷键F12调出界面,该界面称为开发者模式

2.知道如何在网页的源代码中找到我们需要的信息。

一般来说,信息可能直接存在于网页的html页面中,但是一些动态加载的信息可能存在于js页面中。有一些网站,它的数据价值比较高,总会有竞争对手抢它的数据,所以会有比较强大的反爬措施,一般初学者很难对付这种反- 爬行措施。一般的静态网页需要你熟悉浏览器的开发者模式,并且能够使用这个工具在网页的源代码中定位你需要的信息的位置。网上有相关的教程,搜索一下就可以找到,更复杂的动态网页,需要对动态加载的页面做一点研究。

3.知道用什么python库来下载、解析、提取和存储网页源代码。

Python 是一种非常简单的编程语言。一方面是因为它的语法简洁。另一方面,在python社区,很多很多的人为我们贡献了很多很多的开源库。在我们编写程序的时候,直接调用这些库可以省去很多工作。比如我分享的爬虫项目中,我使用了以下库:

它们的功能描述如下:

requests :根据url下载网页的源代码

json :用于将网页中的js内容转换为Python字典类型

re : 正则表达式库,用于提取网页中满足一定规则的内容(比如本例中的经纬度信息)

pandas :一个 Python 中操作结构化数据的库,可以实现几乎所有的 Excel 数据操作功能。在此示例中,它用于构造纬度和经度数据。

4. 最后一点就是能够整合这些知识和技术编写代码,可以实现自己的数据爬取需求

这就是为什么我现在倾向于和大家分享具体案例,而不是知识点。但是,知识和技能只有被内化和吸收才能成为自己的。我们的最终目标是解决实际问题。因此,在接触到新技术、新知识点之后,我们必须有意识地进行整合。只有这样,才能提高我们解决实际问题的能力。

最后,如果本文的知识点或想法对你有帮助,请帮我们转发,或者直接点赞,哈哈~如果你觉得编程不合适,也有不需要编程的可视化爬虫工具,点击阅读原文即可理解。 查看全部

网页源代码抓取工具(从百度地图抓取某个区域边缘坐标点的爬虫程序用到)

之前有两篇文章介绍了一个小python爬虫,也给出了源码;

1. Python | 一个小爬虫(上图)(标题太平淡,这种套路后面也没用,因为太标新立异了)

相信喜欢做的粉丝已经在自己的电脑上运行过这个程序了。但是对于刚接触python的人来说,启动一个python爬虫确实会让自己一头雾水,但是如果我们一直写那种基于知识的文章,你也会觉得只有知识点是不会上瘾的。综合考虑后,我还是觉得这种case还是不错的,即使需要多写几篇文章把一个case解释清楚。

没有看过前两篇文章的同学,建议点进去阅读,了解这篇文章的内容。

前面有点废话,说正经的,这个用来从百度地图抓取某个区域的边缘坐标的爬虫程序用到了哪些知识点和技术?我把它们都列出来:

1.需要对网页结构有基本的了解和认识。

我们通常在互联网上浏览网页,信息是在浏览器中显示在页面上的,但是我们使用爬虫抓取的信息是放在网页的源代码中的。(图1是我们看到的页面,图2是页面对应的网页源代码)

图1 人们浏览网页时看到的界面

图2 网页对应的网页源代码

在浏览器中使用快捷键F12调出界面,该界面称为开发者模式

2.知道如何在网页的源代码中找到我们需要的信息。

一般来说,信息可能直接存在于网页的html页面中,但是一些动态加载的信息可能存在于js页面中。有一些网站,它的数据价值比较高,总会有竞争对手抢它的数据,所以会有比较强大的反爬措施,一般初学者很难对付这种反- 爬行措施。一般的静态网页需要你熟悉浏览器的开发者模式,并且能够使用这个工具在网页的源代码中定位你需要的信息的位置。网上有相关的教程,搜索一下就可以找到,更复杂的动态网页,需要对动态加载的页面做一点研究。

3.知道用什么python库来下载、解析、提取和存储网页源代码。

Python 是一种非常简单的编程语言。一方面是因为它的语法简洁。另一方面,在python社区,很多很多的人为我们贡献了很多很多的开源库。在我们编写程序的时候,直接调用这些库可以省去很多工作。比如我分享的爬虫项目中,我使用了以下库:

它们的功能描述如下:

requests :根据url下载网页的源代码

json :用于将网页中的js内容转换为Python字典类型

re : 正则表达式库,用于提取网页中满足一定规则的内容(比如本例中的经纬度信息)

pandas :一个 Python 中操作结构化数据的库,可以实现几乎所有的 Excel 数据操作功能。在此示例中,它用于构造纬度和经度数据。

4. 最后一点就是能够整合这些知识和技术编写代码,可以实现自己的数据爬取需求

这就是为什么我现在倾向于和大家分享具体案例,而不是知识点。但是,知识和技能只有被内化和吸收才能成为自己的。我们的最终目标是解决实际问题。因此,在接触到新技术、新知识点之后,我们必须有意识地进行整合。只有这样,才能提高我们解决实际问题的能力。

最后,如果本文的知识点或想法对你有帮助,请帮我们转发,或者直接点赞,哈哈~如果你觉得编程不合适,也有不需要编程的可视化爬虫工具,点击阅读原文即可理解。

网页源代码抓取工具(小说网站捕捉器是一款非常实用的小工具,一键搞定全部内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 174 次浏览 • 2022-02-20 08:20

小说网站捕手是一款非常实用的小工具,可以帮助用户快速从相关小说网站中提取书籍信息和内容。小说网站捕手采用智能操作方式,无需分析各种代码,直接一键获取全部内容。

小说规则捕手破解版可以通过网站的网页源码解析网站,从而达到抓书的效果,我们只需要通过浏览器,然后链接链接复制到入口网址即可快速下载小说,欢迎大家体验!

【特征】

ePub电子书制作分解工具,支持分章存储的书籍生成ePub文件,也可以将ePub文件分解成多章文本文件。

软件界面

主界面

任务管理

系统设置 + ePub 小部件

分析代码窗口

【软件特色】

自定义规则抓取,可以文章抓取大部分小说网,个别网站分类书籍详细分类,还支持多本抓取;

自带海量预测网站,不定义规则的用户可以直接套用,也可以抓取自己需要的小说;

自带源码查看器,提供链接分析、关键定位、标签分割等工具;

对于大型小说,任务暂存数据库后,可随意中断和恢复;

图书提供多种输出方式:章节文件、独立文本文件、压缩包、ePub电子书等;

支持任务导入,即从文本文件和带有章节页面链接的excel文档中导入任务进行抓取;

所有组件都支持提示信息,即光标停止后会显示相关提示,大部分操作都支持状态栏提示,使用更方便;

支持添加、修改、导入、导出、排序、删除预设网站;

附小工具:ePub电子书制作分解工具,支持分章存储的书籍生成ePub文件,也可以将ePub文件分解成多章文本文件。 查看全部

网页源代码抓取工具(小说网站捕捉器是一款非常实用的小工具,一键搞定全部内容)

小说网站捕手是一款非常实用的小工具,可以帮助用户快速从相关小说网站中提取书籍信息和内容。小说网站捕手采用智能操作方式,无需分析各种代码,直接一键获取全部内容。

小说规则捕手破解版可以通过网站的网页源码解析网站,从而达到抓书的效果,我们只需要通过浏览器,然后链接链接复制到入口网址即可快速下载小说,欢迎大家体验!

【特征】

ePub电子书制作分解工具,支持分章存储的书籍生成ePub文件,也可以将ePub文件分解成多章文本文件。

软件界面

主界面

任务管理

系统设置 + ePub 小部件

分析代码窗口

【软件特色】

自定义规则抓取,可以文章抓取大部分小说网,个别网站分类书籍详细分类,还支持多本抓取;

自带海量预测网站,不定义规则的用户可以直接套用,也可以抓取自己需要的小说;

自带源码查看器,提供链接分析、关键定位、标签分割等工具;

对于大型小说,任务暂存数据库后,可随意中断和恢复;

图书提供多种输出方式:章节文件、独立文本文件、压缩包、ePub电子书等;

支持任务导入,即从文本文件和带有章节页面链接的excel文档中导入任务进行抓取;

所有组件都支持提示信息,即光标停止后会显示相关提示,大部分操作都支持状态栏提示,使用更方便;

支持添加、修改、导入、导出、排序、删除预设网站;

附小工具:ePub电子书制作分解工具,支持分章存储的书籍生成ePub文件,也可以将ePub文件分解成多章文本文件。

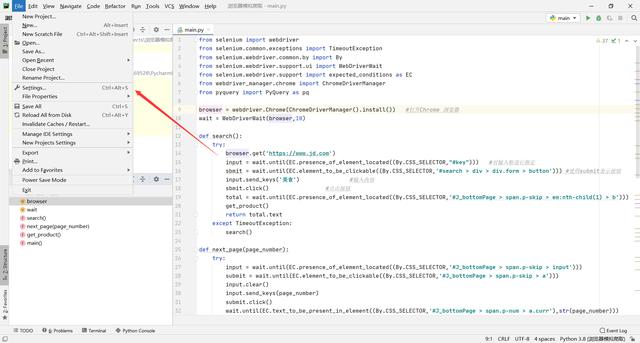

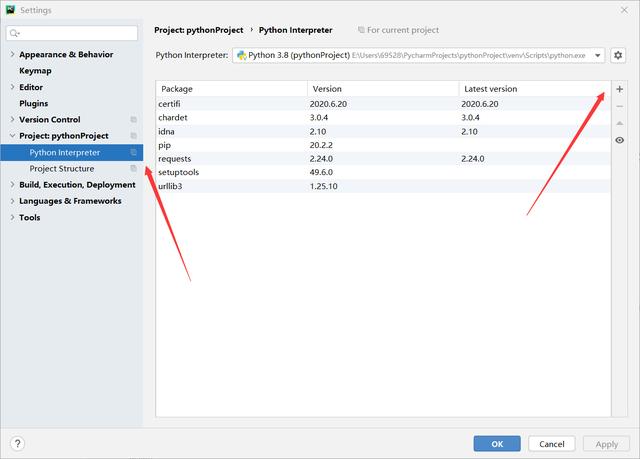

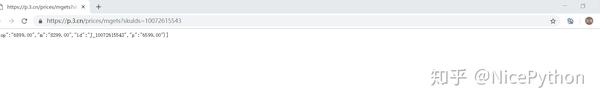

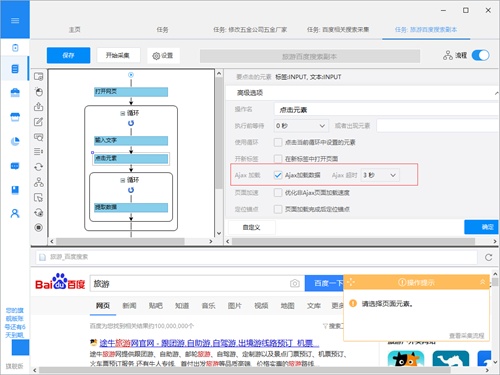

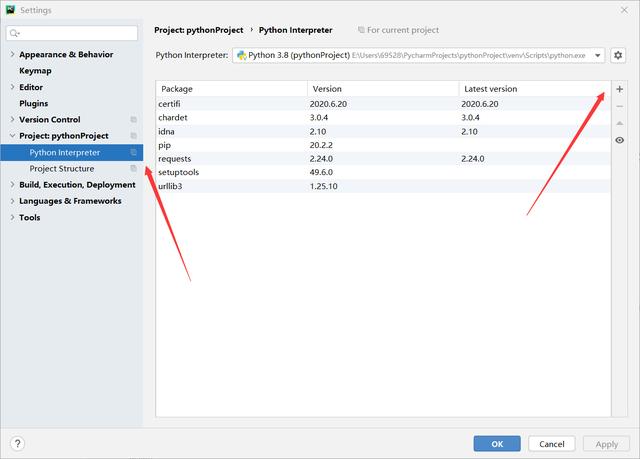

网页源代码抓取工具(环境的搭建以及简单的工具介绍-1.selenium)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-02-16 07:17

一、环境的搭建和简单工具的引入

1.selenium,一个用于 Web 应用程序测试的工具。它的特点是直接在浏览器中运行,就像真正的用户在操作一样。新版本 selenium2 集成了 Selenium1.0 和 WebDriver;

2.webDriver的工作原理是:通过向Webdriver发送指令来执行代码,让Webdriver知道自己要做什么操作,Webdriver会根据这些操作来控制浏览器界面,比如查找页面元素、发送文本等实现事件点击等;

3.pyquery工作原理如下:这里使用的pyquery主要是一个提取html代码数据的库,可以用来代替beautifulsoup和h5的正则表达式提取。

如何导入所需的库:

大部分教程使用pip install命令导入库,但是当你安装了多个python版本或者不知道你的python路径时,可能无法在python中调用下载的python库,所以直接使用pycharm这里要导入,示例如下:

点击文件->设置

点击python解释器右上角的加号,

在界面中搜索需要的库,点击intsall package,即可导入。

二.使用selenium模拟浏览器访问京东页面。

以上功能是打开京东,在搜索框中输入内容框指示的部分,然后搜索。如果代码报错无法打开chrome,是因为没有使用webdriver_manager库。添加此库以在线自动下载 chromedriver。是的 webdriver.chrome 作品。

三. 模拟连续翻页,方便搜索

功能代码如下:

def next_page(page_number): try: input = wait.until(EC.presence_of_element_located((By.CSS_SELECTOR,'#J_bottomPage > span.p-skip > input'))) submit = wait.until(EC.element_to_be_clickable((By.CSS_SELECTOR,'#J_bottomPage > span.p-skip > a'))) input.clear() input.send_keys(page_number) submit.click() wait.until(EC.text_to_be_present_in_element((By.CSS_SELECTOR,'#J_bottomPage > span.p-num > a.curr'),str(page_number))) get_product() except TimeoutException: next_page(page_number)

函数的功能为模拟在输入框中输入页码page_number,然后使用sunbmit.click语句吗,模拟点击翻页。四.对数据进行抓取,并进行解析。函数代码如下:

def get_product(): # wait.until(EC.presence_of_element_located((By.CSS_SELECTOR,'#J_goodsList .gl-warp .gl-item'))) #检测图片是否加载完成 html = browser.page_source #获取网页源代码 doc = pq(html) items = doc('#J_goodsList .gl-warp .gl-item').items() #获取所有的选择内容 for item in items: product = { 'image': item.find('.p-img img').attr('src'), #通过获取src属性来获取图片 'price': item.find('.p-price').text(), #获取文字内容 'name': item.find('.p-name').text(), #获取物品标题 'shop': item.find('.p-shop').text() #获取商铺信息 } print(product)

此处使用到的库为pyquery,通过selenium库对网页源代码进行获取,然后通过pyquery的find语句查找相应的元素装载到product中,最后进行打印。

最后小编想说:我是一名python开发工程师,整理了一套最新的python系统学习教程。如果你想要这些资料,可以关注私信小编“01”(免费分享)希望能帮到你。 查看全部

网页源代码抓取工具(环境的搭建以及简单的工具介绍-1.selenium)

一、环境的搭建和简单工具的引入

1.selenium,一个用于 Web 应用程序测试的工具。它的特点是直接在浏览器中运行,就像真正的用户在操作一样。新版本 selenium2 集成了 Selenium1.0 和 WebDriver;

2.webDriver的工作原理是:通过向Webdriver发送指令来执行代码,让Webdriver知道自己要做什么操作,Webdriver会根据这些操作来控制浏览器界面,比如查找页面元素、发送文本等实现事件点击等;

3.pyquery工作原理如下:这里使用的pyquery主要是一个提取html代码数据的库,可以用来代替beautifulsoup和h5的正则表达式提取。

如何导入所需的库:

大部分教程使用pip install命令导入库,但是当你安装了多个python版本或者不知道你的python路径时,可能无法在python中调用下载的python库,所以直接使用pycharm这里要导入,示例如下:

点击文件->设置

点击python解释器右上角的加号,

在界面中搜索需要的库,点击intsall package,即可导入。

二.使用selenium模拟浏览器访问京东页面。

以上功能是打开京东,在搜索框中输入内容框指示的部分,然后搜索。如果代码报错无法打开chrome,是因为没有使用webdriver_manager库。添加此库以在线自动下载 chromedriver。是的 webdriver.chrome 作品。

三. 模拟连续翻页,方便搜索

功能代码如下:

def next_page(page_number): try: input = wait.until(EC.presence_of_element_located((By.CSS_SELECTOR,'#J_bottomPage > span.p-skip > input'))) submit = wait.until(EC.element_to_be_clickable((By.CSS_SELECTOR,'#J_bottomPage > span.p-skip > a'))) input.clear() input.send_keys(page_number) submit.click() wait.until(EC.text_to_be_present_in_element((By.CSS_SELECTOR,'#J_bottomPage > span.p-num > a.curr'),str(page_number))) get_product() except TimeoutException: next_page(page_number)

函数的功能为模拟在输入框中输入页码page_number,然后使用sunbmit.click语句吗,模拟点击翻页。四.对数据进行抓取,并进行解析。函数代码如下:

def get_product(): # wait.until(EC.presence_of_element_located((By.CSS_SELECTOR,'#J_goodsList .gl-warp .gl-item'))) #检测图片是否加载完成 html = browser.page_source #获取网页源代码 doc = pq(html) items = doc('#J_goodsList .gl-warp .gl-item').items() #获取所有的选择内容 for item in items: product = { 'image': item.find('.p-img img').attr('src'), #通过获取src属性来获取图片 'price': item.find('.p-price').text(), #获取文字内容 'name': item.find('.p-name').text(), #获取物品标题 'shop': item.find('.p-shop').text() #获取商铺信息 } print(product)

此处使用到的库为pyquery,通过selenium库对网页源代码进行获取,然后通过pyquery的find语句查找相应的元素装载到product中,最后进行打印。

最后小编想说:我是一名python开发工程师,整理了一套最新的python系统学习教程。如果你想要这些资料,可以关注私信小编“01”(免费分享)希望能帮到你。

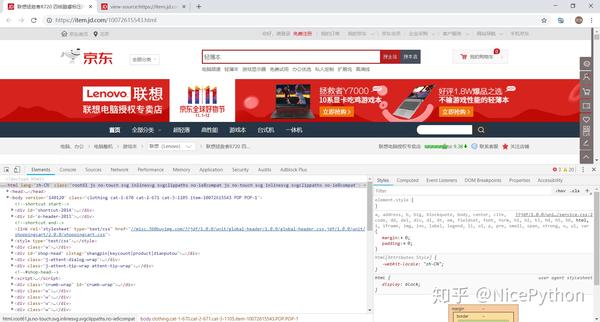

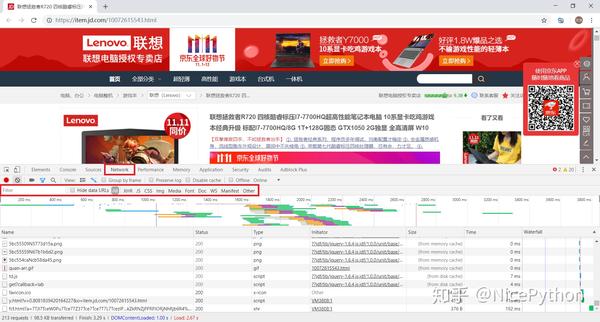

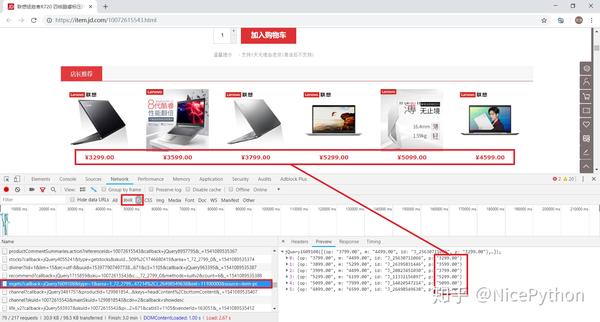

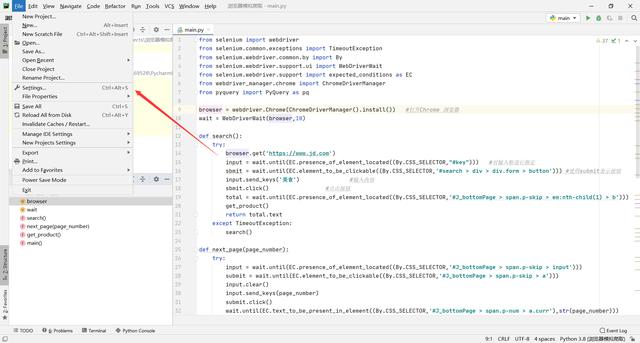

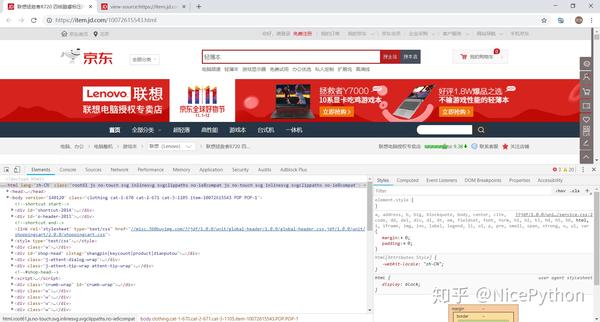

网页源代码抓取工具(网页分析(Chrome开发者工具)对网页抓包分析的本质与内涵)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2022-02-15 06:03

在本期文章中,我们将尝试使用直观的网页分析工具(Chrome Developer Tools)对网页进行抓取和分析,对网页爬虫的本质和内涵有更深入的了解

1、测试环境

浏览器:Chrome浏览器

浏览器版本:67.0.3396.99(正式版)(32位)

网络分析工具:开发者工具

2、网页分析(1)网页源码分析

我们知道网页分为静态网页和动态网页。很多人误以为静态网页就是没有动态效果的网页。事实上,这种说法是错误的。

另外,目前很多动态网站都采用异步加载技术(Ajax),这也是为什么抓到的源码和网站显示的源码不一致的原因,至于怎么爬取动态网页,这里有两种方法:

下面以京东产品为例,分析如何通过Chrome抓包。我们先打开一个产品的首页

/.html

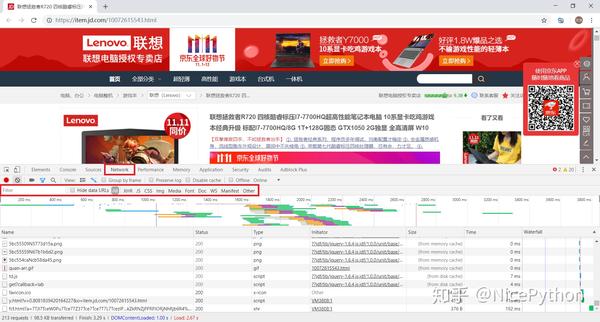

进入网页空白处,右键,选择查看网页源代码(或使用快捷键Ctrl+U直接打开)

请注意查看网页源代码获取的是网站最原创的源代码,通常是我们抓取的源代码

再次进入网页空白处,右键选择Inspect(或使用快捷键Ctrl+Shift+I/F12直接打开)

请注意,检查结果是通过Ajax加载并通过JavaScript渲染的源代码,也就是网站当前显示的内容的源代码

经过对比我们可以发现两者的内容是不一样的,这是异步加载技术(Ajax)的典型例子

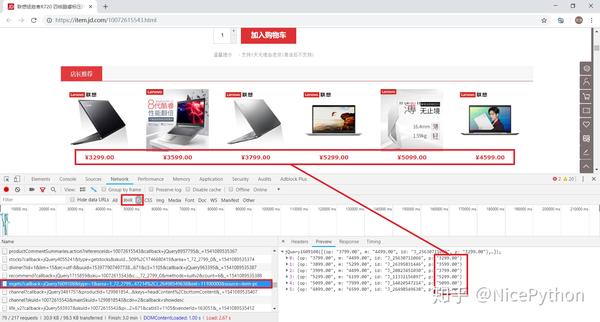

目前,至少京东产品的价格是异步加载生成的。这里有三种方法可以判断网页中的某个内容是否是动态生成的:

(2)网页抓包分析

下面以京东产品为例进行讲解,打开某款产品的首页,尝试抓取动态加载的产品价格数据

/.html

使用快捷键Ctrl+Shift+I或F12打开开发者工具,然后选择Network选项卡进行抓包分析

此时按快捷键F5刷新页面。可以看到开发者工具中出现了各种包。我们使用过滤器来过滤包。

首先,我们选择Doc,我们可以看到列表中只出现了一个包

一般来说,这是浏览器接收到的第一个获取请求原创源代码的数据包网站

点击Header查看其header参数设置

单击响应以查看返回的源代码。不难发现,其实和查看网页源码返回的信息是一样的。

让我们回到主题。对于抓包的动态加载分析,我们主要看XHR和JS选项卡。

选择JS进行过滤,发现列表中有很多包。经过分析,我们过滤掉下图中标记的包。

这个包返回了关于价格的信息,但是仔细分析后发现这些价格不属于当前产品,而是属于相关产品。

但是怎么说这个包还是跟价格有关,我们先来看看这个包的请求URL。

https://p.3.cn/prices/mgets%3F ... em-pc

过滤包括回调在内的不必要参数以获得简单有效的URL

https://p.3.cn/prices/mgets%3F ... 49638

直接用浏览器打开网址,可以看到返回的JSON数据中收录价格信息(可惜是其他商品的价格)

通过分析URL的参数,可以推断出skuId应该是每个产品的唯一标识,那么在哪里可以找到我们需要的产品的skuId呢?

实际上,SKU是物流、运输等行业常用的缩写。它的全称是Stock Keeping Unit,是库存进出计量的基本单位。现已扩展为统一产品编号的缩写。每个产品都有一个独特的 SKU

回顾一下我们刚刚进入的产品首页,/.html

这不是隐藏了当前产品的唯一编号标识符()吗?试一试!

果然,通过访问商品价格的完整 URL,我们得到了它,/prices/mgets?skuIds=

通过直接访问这个网址,我们可以得到当前产品的价格信息

其实我们也可以适当的泛化URL来适应京东所有产品的价格爬取

很简单,只是将 skuIds 作为参数独立分开,{ID}

通过泛化的URL,理论上只要能获取到产品的skuId,我们就可以访问到对应产品的价格 查看全部

网页源代码抓取工具(网页分析(Chrome开发者工具)对网页抓包分析的本质与内涵)

在本期文章中,我们将尝试使用直观的网页分析工具(Chrome Developer Tools)对网页进行抓取和分析,对网页爬虫的本质和内涵有更深入的了解

1、测试环境

浏览器:Chrome浏览器

浏览器版本:67.0.3396.99(正式版)(32位)

网络分析工具:开发者工具

2、网页分析(1)网页源码分析

我们知道网页分为静态网页和动态网页。很多人误以为静态网页就是没有动态效果的网页。事实上,这种说法是错误的。

另外,目前很多动态网站都采用异步加载技术(Ajax),这也是为什么抓到的源码和网站显示的源码不一致的原因,至于怎么爬取动态网页,这里有两种方法:

下面以京东产品为例,分析如何通过Chrome抓包。我们先打开一个产品的首页

/.html

进入网页空白处,右键,选择查看网页源代码(或使用快捷键Ctrl+U直接打开)

请注意查看网页源代码获取的是网站最原创的源代码,通常是我们抓取的源代码

再次进入网页空白处,右键选择Inspect(或使用快捷键Ctrl+Shift+I/F12直接打开)

请注意,检查结果是通过Ajax加载并通过JavaScript渲染的源代码,也就是网站当前显示的内容的源代码

经过对比我们可以发现两者的内容是不一样的,这是异步加载技术(Ajax)的典型例子

目前,至少京东产品的价格是异步加载生成的。这里有三种方法可以判断网页中的某个内容是否是动态生成的:

(2)网页抓包分析

下面以京东产品为例进行讲解,打开某款产品的首页,尝试抓取动态加载的产品价格数据

/.html

使用快捷键Ctrl+Shift+I或F12打开开发者工具,然后选择Network选项卡进行抓包分析

此时按快捷键F5刷新页面。可以看到开发者工具中出现了各种包。我们使用过滤器来过滤包。

首先,我们选择Doc,我们可以看到列表中只出现了一个包

一般来说,这是浏览器接收到的第一个获取请求原创源代码的数据包网站

点击Header查看其header参数设置

单击响应以查看返回的源代码。不难发现,其实和查看网页源码返回的信息是一样的。

让我们回到主题。对于抓包的动态加载分析,我们主要看XHR和JS选项卡。

选择JS进行过滤,发现列表中有很多包。经过分析,我们过滤掉下图中标记的包。

这个包返回了关于价格的信息,但是仔细分析后发现这些价格不属于当前产品,而是属于相关产品。

但是怎么说这个包还是跟价格有关,我们先来看看这个包的请求URL。

https://p.3.cn/prices/mgets%3F ... em-pc

过滤包括回调在内的不必要参数以获得简单有效的URL

https://p.3.cn/prices/mgets%3F ... 49638

直接用浏览器打开网址,可以看到返回的JSON数据中收录价格信息(可惜是其他商品的价格)

通过分析URL的参数,可以推断出skuId应该是每个产品的唯一标识,那么在哪里可以找到我们需要的产品的skuId呢?

实际上,SKU是物流、运输等行业常用的缩写。它的全称是Stock Keeping Unit,是库存进出计量的基本单位。现已扩展为统一产品编号的缩写。每个产品都有一个独特的 SKU

回顾一下我们刚刚进入的产品首页,/.html

这不是隐藏了当前产品的唯一编号标识符()吗?试一试!

果然,通过访问商品价格的完整 URL,我们得到了它,/prices/mgets?skuIds=

通过直接访问这个网址,我们可以得到当前产品的价格信息

其实我们也可以适当的泛化URL来适应京东所有产品的价格爬取

很简单,只是将 skuIds 作为参数独立分开,{ID}

通过泛化的URL,理论上只要能获取到产品的skuId,我们就可以访问到对应产品的价格

网页源代码抓取工具(百度蜘蛛模拟抓取工具seo寻源工具使用教程(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 190 次浏览 • 2022-02-13 23:10

seo source sourcing tool,什么是source:就是找网站的源码,有的网站禁止爬取,有的网站甚至不允许f12进行调试和其他操作。那么我们就需要这样一个软件来查看网页的源代码。

今天给大家分享一款“百度蜘蛛模拟爬虫seo源码工具”。本工具支持多种搜索引擎的模拟爬取,例如:百度搜索引擎、360搜索引擎、搜狗搜索引擎等。本工具可以模拟爬取网页的样式和爬取的源码。作为一个SEO工作者,这个软件对我们很有帮助。让我们专注于这一部分。

蜘蛛模拟爬虫有哪些功能?

1、有没有被骗的链接?

当我们更改友情链接时,我们看网页代码是正常的,但实际上有些人会使用劫持技术阻止百度看到这样的友情链接,我们会被欺骗,所以这部分必须是小心,以免被白白的链接所欺骗。

2. 网站 被劫持了吗?

如果我们的网站被黑了,很容易被黑客劫持。我们正常查看源码没有问题,但是百度爬取源码可能有问题,所以如果你的网站排名持续下降,你还是找不到,问题,你需要用这个软件查,有的黑客很聪明,他们不会霸占你的百度排名,他们会去你的360,搜狗,因为百度的站长工具是可以查的,而且360、平均搜狗上的人很少查,所以有些人网站360很容易被K,一部分是这个操作造成的。

3.检查网站蜘蛛爬行是否正常!

第三点是检查自己的页面。对于一些功能性网站,js太多了。百度爬取页面,可能不全。或者我们可以用源码测试一下百度可以爬到哪些部分。很方便。这款软件可以说是SEOR必备软件之一!

蜘蛛模拟爬取SEO源码工具教程!

1.下载软件并打开软件

2.输入你的网址,选择一个好的引擎,然后点击模拟爬行

3.点击查看源码,可以看到蜘蛛爬取的源码。

这个软件使用起来非常简单,但是非常好用。在检查页面是否被黑、是否被欺骗、网页中是否有百度无法抓取的内容时,也可以用来调度360搜索引擎、搜狗搜索引擎、必应搜索引擎等!而我们可以用这个软件来测试,比如我们开发的源码,用这个软件来测试抓取率,是否有问题等等。好了,今天就到这里解释一下,希望这个软件对大家有所帮助.

seo source sourcing tool,什么是source:就是找网站的源码,有的网站禁止爬取,有的网站甚至不允许f12进行调试和其他操作。那么我们就需要这样一个软件来查看网页的源代码。 查看全部

网页源代码抓取工具(百度蜘蛛模拟抓取工具seo寻源工具使用教程(图))

seo source sourcing tool,什么是source:就是找网站的源码,有的网站禁止爬取,有的网站甚至不允许f12进行调试和其他操作。那么我们就需要这样一个软件来查看网页的源代码。

今天给大家分享一款“百度蜘蛛模拟爬虫seo源码工具”。本工具支持多种搜索引擎的模拟爬取,例如:百度搜索引擎、360搜索引擎、搜狗搜索引擎等。本工具可以模拟爬取网页的样式和爬取的源码。作为一个SEO工作者,这个软件对我们很有帮助。让我们专注于这一部分。

蜘蛛模拟爬虫有哪些功能?

1、有没有被骗的链接?

当我们更改友情链接时,我们看网页代码是正常的,但实际上有些人会使用劫持技术阻止百度看到这样的友情链接,我们会被欺骗,所以这部分必须是小心,以免被白白的链接所欺骗。

2. 网站 被劫持了吗?

如果我们的网站被黑了,很容易被黑客劫持。我们正常查看源码没有问题,但是百度爬取源码可能有问题,所以如果你的网站排名持续下降,你还是找不到,问题,你需要用这个软件查,有的黑客很聪明,他们不会霸占你的百度排名,他们会去你的360,搜狗,因为百度的站长工具是可以查的,而且360、平均搜狗上的人很少查,所以有些人网站360很容易被K,一部分是这个操作造成的。

3.检查网站蜘蛛爬行是否正常!

第三点是检查自己的页面。对于一些功能性网站,js太多了。百度爬取页面,可能不全。或者我们可以用源码测试一下百度可以爬到哪些部分。很方便。这款软件可以说是SEOR必备软件之一!

蜘蛛模拟爬取SEO源码工具教程!

1.下载软件并打开软件

https://www.u0m.cn/wp-content/ ... 1.jpg 900w, https://www.u0m.cn/wp-content/ ... 3.jpg 1024w, https://www.u0m.cn/wp-content/ ... 7.jpg 768w" />

https://www.u0m.cn/wp-content/ ... 1.jpg 900w, https://www.u0m.cn/wp-content/ ... 3.jpg 1024w, https://www.u0m.cn/wp-content/ ... 7.jpg 768w" />2.输入你的网址,选择一个好的引擎,然后点击模拟爬行

https://www.u0m.cn/wp-content/ ... 6.jpg 900w, https://www.u0m.cn/wp-content/ ... 0.jpg 1024w, https://www.u0m.cn/wp-content/ ... 0.jpg 768w" />

https://www.u0m.cn/wp-content/ ... 6.jpg 900w, https://www.u0m.cn/wp-content/ ... 0.jpg 1024w, https://www.u0m.cn/wp-content/ ... 0.jpg 768w" />3.点击查看源码,可以看到蜘蛛爬取的源码。

https://www.u0m.cn/wp-content/ ... 7.jpg 900w, https://www.u0m.cn/wp-content/ ... 2.jpg 1024w, https://www.u0m.cn/wp-content/ ... 9.jpg 768w" />

https://www.u0m.cn/wp-content/ ... 7.jpg 900w, https://www.u0m.cn/wp-content/ ... 2.jpg 1024w, https://www.u0m.cn/wp-content/ ... 9.jpg 768w" />这个软件使用起来非常简单,但是非常好用。在检查页面是否被黑、是否被欺骗、网页中是否有百度无法抓取的内容时,也可以用来调度360搜索引擎、搜狗搜索引擎、必应搜索引擎等!而我们可以用这个软件来测试,比如我们开发的源码,用这个软件来测试抓取率,是否有问题等等。好了,今天就到这里解释一下,希望这个软件对大家有所帮助.

seo source sourcing tool,什么是source:就是找网站的源码,有的网站禁止爬取,有的网站甚至不允许f12进行调试和其他操作。那么我们就需要这样一个软件来查看网页的源代码。

网页源代码抓取工具(如何最高效地从海量信息里获取数据呢?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2022-02-12 21:13

数据已进入各行各业并得到广泛应用,应用随之而来的是数据的获取和精准挖掘。我们可以应用的大部分数据来自内部资源库和外部运营商。内部数据已集成并可以使用,而外部数据则需要先获取。外部数据的最大载体是互联网。网页中无数的增量数据收录了很多对我们有用的信息。

如何最有效地从海量信息中获取数据?网页抓取工具优采云采集器有大招,用自动化的智能工具代替人工采集数据,当然效率更高,准确率更高。

一、数据抓取的一般性

作为一款通用的网页爬虫工具,基于源码的优采云采集器运行原理,可以爬取的网页类型达到99%,并具有自动登录、验证码识别、IP代理以及应对网站预防采集措施的其他功能;采集对象的格式可以是文本、图片、音频、文件等,无需繁琐的操作,数据采集简单。

二、数据抓取的效率

效率是大数据时代对数据应用的又一重要要求。随着信息的爆炸式增长,如果跟不上速度,就会错过数据利用的最佳节点,因此数据获取的效率非常高。过去我们使用手动采集数据,一天最多爬几百条数据,但是当网络爬虫稳定运行时,每天可以达到10万条,比手动好上百倍< @采集。

三、数据采集的准确性

长期用肉眼辨别和提取信息可能会造成疲劳,但软件识别可以继续提取,准确率很高。但是需要注意的是,当采集不同类型的网站或者数据时,优采云采集器配置的规则是不同的。只有分析具体情况,才能保证高性能。准确性。

响应大数据时代的号召,重视数据资源,善用网络抓取工具优采云采集器和优采云浏览器,轻松将数据收进包里,实现数据资产的高利用率和价值实现! 查看全部

网页源代码抓取工具(如何最高效地从海量信息里获取数据呢?(图))

数据已进入各行各业并得到广泛应用,应用随之而来的是数据的获取和精准挖掘。我们可以应用的大部分数据来自内部资源库和外部运营商。内部数据已集成并可以使用,而外部数据则需要先获取。外部数据的最大载体是互联网。网页中无数的增量数据收录了很多对我们有用的信息。

如何最有效地从海量信息中获取数据?网页抓取工具优采云采集器有大招,用自动化的智能工具代替人工采集数据,当然效率更高,准确率更高。

一、数据抓取的一般性

作为一款通用的网页爬虫工具,基于源码的优采云采集器运行原理,可以爬取的网页类型达到99%,并具有自动登录、验证码识别、IP代理以及应对网站预防采集措施的其他功能;采集对象的格式可以是文本、图片、音频、文件等,无需繁琐的操作,数据采集简单。

二、数据抓取的效率

效率是大数据时代对数据应用的又一重要要求。随着信息的爆炸式增长,如果跟不上速度,就会错过数据利用的最佳节点,因此数据获取的效率非常高。过去我们使用手动采集数据,一天最多爬几百条数据,但是当网络爬虫稳定运行时,每天可以达到10万条,比手动好上百倍< @采集。

三、数据采集的准确性

长期用肉眼辨别和提取信息可能会造成疲劳,但软件识别可以继续提取,准确率很高。但是需要注意的是,当采集不同类型的网站或者数据时,优采云采集器配置的规则是不同的。只有分析具体情况,才能保证高性能。准确性。

响应大数据时代的号召,重视数据资源,善用网络抓取工具优采云采集器和优采云浏览器,轻松将数据收进包里,实现数据资产的高利用率和价值实现!

网页源代码抓取工具(使用优采云采集器软件从指定网页获取特定内容的几种解决方案)

网站优化 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2022-02-11 04:11

网页数据抓取是指从网站中提取特定内容,而不需要请求网站的API接口来获取内容。“网页数据” 作为网站 用户体验的一部分,例如网页上的文本、图像、声音、视频和动画,它们都是网页数据。

对于程序员或开发人员来说,拥有编程技能使得构建网络抓取程序变得非常容易和有趣。但是对于大多数没有任何编程知识的人来说,最好使用一些网络爬虫软件从指定的网页中获取特定的内容。以下是一些使用 优采云采集器 抓取 Web 数据的解决方案:

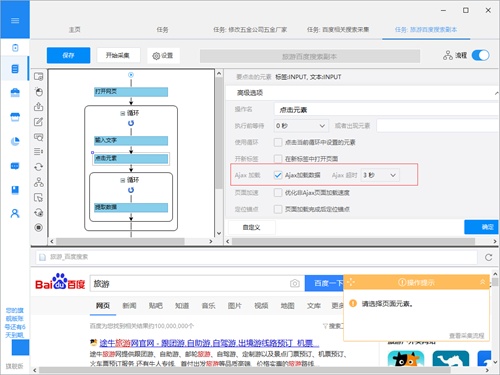

1、从动态网页中提取内容

网页可以是静态的或动态的。通常,您要提取的网页内容会随着您访问 网站 的时间而改变。通常,这个 网站 是一个动态的网站,它使用 AJAX 或其他技术来使 Web 内容保持最新。AJAX 是一种延迟加载和异步更新的脚本技术。通过在后台与服务器交换少量数据,可以在不重新加载整个网页的情况下更新网页的某一部分。

性能特点是当点击网页中的某个选项时,网站的大部分URL都不会改变;网页没有完全加载,而只是部分加载了数据,这些数据会发生变化。这时候可以在优采云的“高级选项”元素的“Ajax加载”中进行设置,就可以抓取Ajax加载的网页数据了。

优采云 中的 AJAX 设置

2、从网页中抓取隐藏的内容

你有没有想过从 网站 获取特定的数据,但是当你触发链接或鼠标悬停在某处时,内容就会出现?例如下图中的网站,需要将鼠标移到选中的彩票上,才能显示类别。对于此功能,您可以设置“鼠标悬停在链接上”功能来捕捉网页中的隐藏内容。.

将鼠标移到链接上的 content采集 方法

3、从无限滚动的网页中提取内容

滚动到页面底部后,有些网站只有你要提取的一部分数据。比如今日头条首页,需要不断滚动到页面底部加载更多文章内容,无限滚动网站一般使用AJAX或者JavaScript向网站@请求额外内容> 内容。在这种情况下,您可以设置 AJAX 超时设置并选择滚动方式和滚动时间以从网页中提取内容。

4、 从网络上抓取所有链接

一个普通的网站会收录至少一个超链接,如果你想从一个网页中提取所有的链接,你可以使用优采云来获取网页上发布的所有超链接。

5、从网页中抓取所有文本

有时您需要提取 HTML 文档中的所有文本,即放置在 HTML 标记中,例如

标签或标签)。优采云使您能够提取网页源代码中的所有或特定文本。

6、 从网络上抓取所有图片

有的朋友有采集网页图片的需求。优采云可以下载网页中图片的URL采集,然后下载使用优采云专用的图片批量下载工具,即可下载图片URL中的图片我们 采集 到。下载并保存到本地计算机。 查看全部

网页源代码抓取工具(使用优采云采集器软件从指定网页获取特定内容的几种解决方案)

网页数据抓取是指从网站中提取特定内容,而不需要请求网站的API接口来获取内容。“网页数据” 作为网站 用户体验的一部分,例如网页上的文本、图像、声音、视频和动画,它们都是网页数据。

对于程序员或开发人员来说,拥有编程技能使得构建网络抓取程序变得非常容易和有趣。但是对于大多数没有任何编程知识的人来说,最好使用一些网络爬虫软件从指定的网页中获取特定的内容。以下是一些使用 优采云采集器 抓取 Web 数据的解决方案:

1、从动态网页中提取内容

网页可以是静态的或动态的。通常,您要提取的网页内容会随着您访问 网站 的时间而改变。通常,这个 网站 是一个动态的网站,它使用 AJAX 或其他技术来使 Web 内容保持最新。AJAX 是一种延迟加载和异步更新的脚本技术。通过在后台与服务器交换少量数据,可以在不重新加载整个网页的情况下更新网页的某一部分。

性能特点是当点击网页中的某个选项时,网站的大部分URL都不会改变;网页没有完全加载,而只是部分加载了数据,这些数据会发生变化。这时候可以在优采云的“高级选项”元素的“Ajax加载”中进行设置,就可以抓取Ajax加载的网页数据了。

优采云 中的 AJAX 设置

2、从网页中抓取隐藏的内容

你有没有想过从 网站 获取特定的数据,但是当你触发链接或鼠标悬停在某处时,内容就会出现?例如下图中的网站,需要将鼠标移到选中的彩票上,才能显示类别。对于此功能,您可以设置“鼠标悬停在链接上”功能来捕捉网页中的隐藏内容。.

将鼠标移到链接上的 content采集 方法

3、从无限滚动的网页中提取内容

滚动到页面底部后,有些网站只有你要提取的一部分数据。比如今日头条首页,需要不断滚动到页面底部加载更多文章内容,无限滚动网站一般使用AJAX或者JavaScript向网站@请求额外内容> 内容。在这种情况下,您可以设置 AJAX 超时设置并选择滚动方式和滚动时间以从网页中提取内容。

4、 从网络上抓取所有链接

一个普通的网站会收录至少一个超链接,如果你想从一个网页中提取所有的链接,你可以使用优采云来获取网页上发布的所有超链接。

5、从网页中抓取所有文本

有时您需要提取 HTML 文档中的所有文本,即放置在 HTML 标记中,例如

标签或标签)。优采云使您能够提取网页源代码中的所有或特定文本。

6、 从网络上抓取所有图片

有的朋友有采集网页图片的需求。优采云可以下载网页中图片的URL采集,然后下载使用优采云专用的图片批量下载工具,即可下载图片URL中的图片我们 采集 到。下载并保存到本地计算机。

网页源代码抓取工具(相关专题蜘蛛爬行不顺畅?当务之急是清理网站陷阱! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2022-02-09 12:19

)

相关话题

蜘蛛爬行不顺畅?首要任务是清除 网站 陷阱!

25/9/2017 09:09:00

事情发生一定是有原因的,蜘蛛只是一个机器人,它是由程序代码组成的,它必须按照它的规定去爬网站,如果有一些网站陷阱在< @网站,会让蜘蛛爬行不顺畅,导致一系列问题。哪些网站 陷阱是蜘蛛爬行的绊脚石?

蜘蛛爬行不顺畅?首要任务是清除 网站 陷阱!

25/9/2017 09:09:00

事情发生一定是有原因的,蜘蛛只是一个机器人,它是由程序代码组成的,它必须按照它的规定去爬网站,如果有一些网站陷阱在< @网站,会让蜘蛛爬行不顺畅,导致一系列问题。哪些网站 陷阱是蜘蛛爬行的绊脚石?

WordPress搜索引擎爬取记录代码

19/1/2012 15:36:00

我写博客已经有一段时间了,为什么搜索引擎没有收录你的页面?想知道每天有哪些蜘蛛“访问”您的 网站?作为wordpress用户,需要知道每天有哪些蜘蛛在抓取你的网站,从而了解各个搜索引擎的蜘蛛抓取频率,对网站进行针对性的SEO优化。

浅析新站如何引蜘蛛爬行网站

22/6/2011 14:36:00

新站点没有权重,没有更新规则,没有稳定的用户,也没有强大的外部链接。这就是站长们在思考如何增加网站的权重以及如何吸引蜘蛛爬取网站。再好一个网站,如果没有蜘蛛爬网站,搜索引擎不收录网站也不乐观。新站如何吸引蜘蛛爬网站?

浅谈提高网站爬取能力的五个步骤

24/11/2011 10:32:00

我们煞费苦心地吸引蜘蛛,希望能索引 网站。而一个新的可爬高网站意味着蜘蛛指数极其深广,这也会给我们带来更多的收录和更均衡的权重。那么如何构建一个高度爬取的网站呢?

蜘蛛爬行不顺畅?清理 网站 陷阱是关键

26/6/2013 10:10:00

蜘蛛的爬取往往决定了网站的收录,所以在平时的优化工作中,我们会比较关注iis日志,通过观察爬取网站的动态来获取蜘蛛爬取网站的动态。日志,并通过分析蜘蛛动态来监控网站优化进度。但是很多时候,站长会看到他们的iis日志显示蜘蛛的爬取非常不流畅,尽管他们认为网站优化是完美的。造成这种情况的原因是什么?

SEO现场优化技巧:如何诊断和改善网站的爬取

2011 年 12 月 31 日 09:41:00

当您查看 网站 时,无论是针对您自己的项目还是针对客户的项目,希望 网站 被抓取很重要。在这篇 文章 中,我希望讨论其中的一些问题并诊断一些爬虫问题。

如何“欺骗”蜘蛛抓取搜索引擎网站

28/10/2010 15:19:00

如何让百度收录成为我们的文章?百度的快照怎么能靠蜘蛛的爬取更新?依靠蜘蛛的爬取,如何让搜索引擎知道你的网站?我们需要蜘蛛来爬,所以我们做SEO推广的时候,蜘蛛无处不在。如果蜘蛛喜欢你的网站,那么恭喜你,因为你的信息已经被蜘蛛携带给服务器了

宝宝爬行武器!小米众筹新品:天然软木拼接爬行垫售价169元

22/6/2017 11:29:00

对于经常在地上爬行的宝宝来说,有一个干净的爬垫还是很重要的。今日,小米米家众筹推出第93款产品:橡树天然软木拼接爬行垫,以软木材质为主,具有耐折叠防滑、易打理、安全无毒等特点。众筹价格为169元。

查看全部

网页源代码抓取工具(相关专题蜘蛛爬行不顺畅?当务之急是清理网站陷阱!

)

相关话题

蜘蛛爬行不顺畅?首要任务是清除 网站 陷阱!

25/9/2017 09:09:00

事情发生一定是有原因的,蜘蛛只是一个机器人,它是由程序代码组成的,它必须按照它的规定去爬网站,如果有一些网站陷阱在< @网站,会让蜘蛛爬行不顺畅,导致一系列问题。哪些网站 陷阱是蜘蛛爬行的绊脚石?

蜘蛛爬行不顺畅?首要任务是清除 网站 陷阱!

25/9/2017 09:09:00

事情发生一定是有原因的,蜘蛛只是一个机器人,它是由程序代码组成的,它必须按照它的规定去爬网站,如果有一些网站陷阱在< @网站,会让蜘蛛爬行不顺畅,导致一系列问题。哪些网站 陷阱是蜘蛛爬行的绊脚石?

WordPress搜索引擎爬取记录代码

19/1/2012 15:36:00

我写博客已经有一段时间了,为什么搜索引擎没有收录你的页面?想知道每天有哪些蜘蛛“访问”您的 网站?作为wordpress用户,需要知道每天有哪些蜘蛛在抓取你的网站,从而了解各个搜索引擎的蜘蛛抓取频率,对网站进行针对性的SEO优化。

浅析新站如何引蜘蛛爬行网站

22/6/2011 14:36:00

新站点没有权重,没有更新规则,没有稳定的用户,也没有强大的外部链接。这就是站长们在思考如何增加网站的权重以及如何吸引蜘蛛爬取网站。再好一个网站,如果没有蜘蛛爬网站,搜索引擎不收录网站也不乐观。新站如何吸引蜘蛛爬网站?

浅谈提高网站爬取能力的五个步骤

24/11/2011 10:32:00

我们煞费苦心地吸引蜘蛛,希望能索引 网站。而一个新的可爬高网站意味着蜘蛛指数极其深广,这也会给我们带来更多的收录和更均衡的权重。那么如何构建一个高度爬取的网站呢?

蜘蛛爬行不顺畅?清理 网站 陷阱是关键

26/6/2013 10:10:00

蜘蛛的爬取往往决定了网站的收录,所以在平时的优化工作中,我们会比较关注iis日志,通过观察爬取网站的动态来获取蜘蛛爬取网站的动态。日志,并通过分析蜘蛛动态来监控网站优化进度。但是很多时候,站长会看到他们的iis日志显示蜘蛛的爬取非常不流畅,尽管他们认为网站优化是完美的。造成这种情况的原因是什么?

SEO现场优化技巧:如何诊断和改善网站的爬取

2011 年 12 月 31 日 09:41:00

当您查看 网站 时,无论是针对您自己的项目还是针对客户的项目,希望 网站 被抓取很重要。在这篇 文章 中,我希望讨论其中的一些问题并诊断一些爬虫问题。

如何“欺骗”蜘蛛抓取搜索引擎网站

28/10/2010 15:19:00

如何让百度收录成为我们的文章?百度的快照怎么能靠蜘蛛的爬取更新?依靠蜘蛛的爬取,如何让搜索引擎知道你的网站?我们需要蜘蛛来爬,所以我们做SEO推广的时候,蜘蛛无处不在。如果蜘蛛喜欢你的网站,那么恭喜你,因为你的信息已经被蜘蛛携带给服务器了

宝宝爬行武器!小米众筹新品:天然软木拼接爬行垫售价169元

22/6/2017 11:29:00

对于经常在地上爬行的宝宝来说,有一个干净的爬垫还是很重要的。今日,小米米家众筹推出第93款产品:橡树天然软木拼接爬行垫,以软木材质为主,具有耐折叠防滑、易打理、安全无毒等特点。众筹价格为169元。

网页源代码抓取工具(网络推广方法优化人员坚持不懈提升网站页面页面收录的技巧)

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-02-08 02:13

优化人员在优化网络推广方式的同时,也要注意优化效果,比如网站的收录情况、权重情况和排名情况等,但有时< @网站页面不收录对优化器来说也是很麻烦的。下面的网络推广方法将为您展示提升网站页面收录的技巧,帮助网站更快地提升排名。

一、内容原创性别

<p>众所周知,优质、原创性、创新性文章可以为网站带来更多收益,吸引更多流量,提升用户体验,所以我想 查看全部

网页源代码抓取工具(网络推广方法优化人员坚持不懈提升网站页面页面收录的技巧)

优化人员在优化网络推广方式的同时,也要注意优化效果,比如网站的收录情况、权重情况和排名情况等,但有时< @网站页面不收录对优化器来说也是很麻烦的。下面的网络推广方法将为您展示提升网站页面收录的技巧,帮助网站更快地提升排名。

一、内容原创性别

<p>众所周知,优质、原创性、创新性文章可以为网站带来更多收益,吸引更多流量,提升用户体验,所以我想

网页源代码抓取工具( 一个名为Bing开发助手(BDA)的示例代码以学习如何解决与编程相关的问题)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-02-08 02:13

一个名为Bing开发助手(BDA)的示例代码以学习如何解决与编程相关的问题)

引用:H. Zhang、A. Jain、G. Khandelwal、C. Kaushik、S. Ge、W. Hu,“Bing 开发人员助手:通过推荐示例代码提高开发人员生产力”,软件基础国际研讨会论文集工程,第 956-961 页,2016.

概括

在编程实践中,开发人员经常需要示例代码来学习如何解决与编程相关的问题。例如,如何重用大型软件库的应用程序编程接口(API),如何实现某个功能。我们相信,以前编写的代码可以帮助开发人员编写新程序,帮助他们了解其他人是如何解决类似问题的。我们开发了一个名为 Bing Development Assistant (BDA) 的工具,它通过推荐从公共软件存储库(如 GitHub)和网页(如 Stack Overflow)中挖掘的示例代码来提高开发人员的工作效率。BDA 可以自动挖掘实现 API 或回答代码搜索的代码片段。它是作为 Microsoft Visual Studio 的免费插件实现的,自 2014 年 12 月首次发布以来已获得超过 670K 的下载量。

1.简介

编程有时很难。在实践中,开发人员经常面临许多与解决问题相关的挑战。例如,开发人员经常想知道如何实现某个功能(例如,如何在 C# 中以 PNG 格式保存图像)。虽然 API(应用程序编程接口,如 .NET Framework 中的 Image.Save 和 Image.Tag 方法)提供了一种重要的软件重用形式并被广泛用于有效解决问题,但开发人员仍然需要知道“如何重用 API? ”。.NET 框架等大型软件框架可能收录数百甚至数千个 API。程序员通常不记得应该如何重用 API 函数。许多 API 也没有很好的文档记录。在 2009 年微软进行的一项调查中,67. 6% 的受访者表示学习 API 的资源不足或缺乏是一个障碍。除了 API 功能,开发人员可能还需要了解公共类、结构或属性的用法。因此,希望开发者遇到编程困难时,IDE提供API使用示例代码。

多年来,已经开发和部署了数百万个软件程序。这些程序的源代码通常存储在软件存储库(例如 GitHub)中,可以作为开发人员的重要可重用资产。以前编写的程序可以帮助开发人员了解其他人是如何解决类似问题的,并且可以作为编写新程序的基础。此外,Stack Overflow 等以开发人员为中心的在线问答 (QA) 论坛的出现为解决编程相关问题提供了丰富的资源(包括示例代码)。

许多现代集成开发环境(IDE,例如 Microsoft Visual Studio)为高效开发程序提供了丰富的功能。但是,大多数 IDE 不向开发人员提供示例代码。虽然开发人员可以使用 Bing 或 Google 等常规 Web 搜索引擎来查找解决方案,但他们通常需要经常离开 IDE 环境并在 IDE 和 Web 浏览器之间切换上下文。这会导致生产率降低。此外,某些网络搜索引擎可能无法很好地支持与编程相关的问题,例如使用某个 API。

我们开发了一种称为 Bing 开发助手 (BDA) 的工具,通过挖掘软件存储库和网页来帮助提高开发人员的工作效率。我们将 BDA 的后端部署为 Microsoft Azure 服务,并将前端实现为 Visual Studio 扩展。BDA 可以通过 Visual Studio 的 IntelliSense 功能自动检测当前编程上下文中正在编辑的 API,并提供收录 API 使用情况的示例代码。BDA 还利用 Bing 搜索引擎来支持基于自由文本的代码搜索查询。BDA 为示例解决方案提供本地入口,以更有效地完成任务。

目前,BDA 支持 C/C++/C# 语言。它在开发人员中很受欢迎。自 2014 年 12 月首次发布以来,它已吸引了超过 670,000 次下载。BDA 现在可在以下网址下载: 。我们还扩展了 BDA 以支持更多语言(如 Java 和 JavaScript)和更多用例。

2.从软件仓库获取示例代码

在本节中,我们描述了一个从软件存储库中提取 API 示例代码的框架。示例代码用于了解各种 API 的使用,包括公共类、函数、结构、属性等。图 1 显示了我们方法的一般框架。我们首先通过 网站 从 MSDN 和 GitHub 等中抓取源代码项目来构建大型软件存储库。存储库收录用不同语言编写的源文件,例如 C/C++/C#/Java。然后,我们利用 Clang[1](用于 C/C++)、Roslyn[2](用于 C#)和 JDT[3](用于 Java)等编译器来静态分析这些源文件并生成中间表示(抽象语法树) . 可以从 AST 中推断出 API 相关的源代码信息。生成的 API 使用数据,包括有关项目、文件、行等的信息,存储在 Azure 表 [4] 中。最后,可以提取相关示例代码使用(Visual Studio IDE等客户端)。特别是,我们开发了一个静态分析器,它将源代码文件解析为 AST,然后在访问每个 AST 节点时执行数据提取。分析器基于编译器前端(例如 Clang 的 LibTooling,一个用于公开 AST 的库)。这样我们就不需要任何 .dll 或 .so 文件或任何特定的运行时环境

图 1:从软件存储库中挖掘 API 使用情况

静态分析器使用的算法如图2所示:

图 2:提取 API 使用 d 的算法

它收录三个主要部分:第一个(Main)是将源代码文件解析成一个AST,第二个(Visit)是遍历AST中的节点,第三个(Process_*)是一组AST对应的不同类型的节点功能。给定源代码文件和头文件应该驻留的目录,分析器解析源代码文件和相关的头文件。源代码文件的 AST 和头文件的 AST 组合成一个大的 AST 作为中间表示。在生成组合的 AST 后,分析器执行 AST 的有序遍历。当分析器访问我们感兴趣的节点时,例如函数调用或变量声明,它会按类型进一步处理 AST 节点。在图 2 中,我们只展示了处理函数调用的伪代码。

我们使用一个 API 调用示例来说明该算法(图 3)。图 3 收录整个 AST 的片段,以及两个相应的源代码文件。当我们访问“ac”的节点时,我们发现一个节点实际上上面是一个函数调用——"foo(1)"。我们使用被调用者的标识符在头文件的AST节点中查找它的有效声明。结果,我们发现声明节点在“ah”是我们想要的。然后我们检查这个文件的来源。在这种情况下,“ah”文件与“ac”来自同一目录,因此我们将其标记为用户定义的API并记录下来以及“ac”中的源代码位置。

图 3:API 调用示例

我们面临的一个挑战是第 3 方库支持。这实际上体现在图 2 中的 Which_Library 函数中。我们需要知道 foo 来自哪个库 API。如果我们可以解决依赖关系(例如,在 C# 的情况下,它的依赖关系可以在 Nuget[5] 的帮助下解决),我们构建一个对列表。将源代码文件解析成AST,访问AST中的每个节点后,我们就可以提取出我们想知道的API,搜索对应的库名。

但是,在某些语言(如C/C++)中,由于项目的平台/环境设置,我们通常无法通过执行make文件来成功构建项目。解决所有项目依赖关系也不容易。由于缺乏相关的头文件,某些第三方库的缺乏使得识别第三方库的 API 更具挑战性。考虑图 3 中描述的情况,如果头文件“ah”丢失,我们只知道 foo 是一个函数调用语句,但我们不知道函数在哪里声明。在这种情况下,我们将无法编译源代码文件。

BDA 支持常用第三方库的列表。我们使用 Nuget 和 GitHub 来选择最流行的第三方库(例如,我们为 C/C++ 选择了 1200 个流行的库),这些库被开发者社区广泛使用。我们还生成了一个对列表,其中 libname 代表第三方库的名称,path 代表头文件的确切路径。在程序分析期间,我们获得了被分析的 API 的路径,并

在列表中搜索。这样,即使我们无法成功构建项目,也可以获得API所属的第3方库。

处理完软件仓库中的所有项目后,我们得到API使用数据(包括API名称、所属库、项目、文件、行号等信息)。我们将此数据存储在 Microsoft Azure 表中。根据数据的用途,可以针对各种应用场景轻松检索 API 的示例代码

在 BDA 客户端中,我们侦听 Visual Studio 的 IntelliSense[6] 接口以获取正在编辑的程序的上下文。IntelliSense 接口可以自动为开发人员提供可在当前编程上下文中使用的 API 列表。此类 API 信息用于在 Visual Studio 环境中触发我们的 BDA 示例代码服务。

3.从 Bing 搜索引擎获取解决方案

为了帮助开发者了解如何实现某个功能,我们将代码搜索组件集成到开发者助手中。开发人员可以输入描述问题的自然语言查询(例如,如何保存图像)。BDA 可以使用 Bing 搜索引擎 ( ) 自动调用网络搜索并从返回的网页(例如 Stack Overflow 和 MSDN 网页)中获取相关片段。图 4 显示了使用 Bing 进行挖掘的示例代码的总体框架

图 4:使用 Bing 挖掘示例代码

给定用户查询,BDA 首先通过附加当前编程上下文中使用的编程语言来扩展原创查询(例如“如何在 c# 中保存图像”)。然后它会调用 Bing 搜索引擎来查找与该查询相关的网页。在检索到前 10 个网页后,BDA 识别并从 HTML 页面中提取代码(基于 HTML 标签,如 hprei、hcodei、hpi 和 hdivi)。BDA 还根据相关性和投票/接受的数量对提取的片段进行排名,并将它们显示在 Visual Studio 环境中。这样,用户无需启动单独的 Web 浏览器即可执行代码搜索查询。我们的用户研究表明,每个查询的平均响应时间为 1.5 秒,提供流畅的用户体验。关于 BDA 代码搜索功能的更多细节可以在 [7] 中找到。

除了提供代码片段外,BDA 还支持基于用户查询的示例商品推荐。代码示例项目是开发人员可以下载、构建和运行的完整 Visual Studio 解决方案。收到用户查询后,BDA 可以调用 Bing 搜索引擎从 MSDN 和 GitHub 等站点检索最相关的项目。项目信息(如项目 URL、作者、许可证、评级等)将被提取并显示在 Visual Studio 环境中。通过重用整个解决方案可以提高开发人员的工作效率。

BDA 还可以提供编译错误的解决方案。使用 Visual Studio 编译程序时发生编译错误后,用户只需右键单击并调用上下文搜索即可。BDA 客户端将提取当前上下文(例如错误代码/消息、项目类型、数据类型、正在使用的编程语言等)。然后,它将上下文发送给后端服务,后端服务将从上下文中提取相关功能,生成上下文查询,并调用必应搜索引擎获取编译错误的示例解决方案,并将获取的示例代码返回给用户。例如,假设我们正在编辑一个 C++ 程序并使用“std::string”类来存储“hello world”字符串。如果我们忘记收录头文件“字符串”,Visual Studio 将报告错误消息,如“ string' 不是 'std' 的成员。这个消息可能会让一些新开发者感到困惑。BDA 可以通过提供示例解决方案来帮助他们。错误消息和其他上下文信息会自动组合以形成一个查询,该查询将传递给 BDA 后端服务以进行 Bing 搜索。Bing 搜索结果(在本例中为有关解决相同编译问题的 Stack Overflow 页面)将返回并显示在 Visual Studio 中。

4.工具实现

为了从源代码存储库中获取有关 API 使用的示例代码,我们通过从 MSDN 和 GitHub 上抓取项目来构建一个大规模的代码库。为了移除虚拟项目,对于 GitHub,我们只抓取至少有一颗星的项目。我们总共抓取了 65,253 个项目。这些项目的总大小约为 437 GB,收录约 350 万个源代码文件。表 1 显示了所得结果的统计数据。

API 使用数据和示例代码存储在世界各地的许多 Microsoft Azure 服务器中。索引和检索过程由 Microsoft Azure Table 执行。客户端是一个支持Microsoft Visual Studio (2012-2016)的扩展。我们挂钩到Visual Studio的IntelliSense接口来获取正在编辑的程序的上下文。IntelliSense提供的API触发后端BDA服务。返回API 示例代码将自动从 Azure 服务器获取并显示在 Visual Studio 中。

图 5:推荐 API 示例代码

图 5 显示了 BDA Recommendation API 示例代码的屏幕截图。当用户键入不完整的 API 时,Visual Studio(通过其 IntelliSense 功能)将推荐候选 API 列表。如果用户不知道如何使用这些 API,可以在 Visual Studio 环境中查看 BDA 返回的示例代码。在图 5 中,用户输入了一个不完整的 API 'doc.l...',BDA 自动推荐候选函数 'Load' 的代码片段。

目前,BDA 提供了通过 Bing 搜索从各种网站 中采集的示例代码/项目。这些 网站 包括 Stack Overflow、dotnetperls、C#411、Cppreference 和 MSDN。表 2 显示了截至 2016 年 6 月从两个流行的软件论坛(Stack Overflow 和 MSDN)获得的代码片段总数。

图 6:根据用户 q 推荐示例代码

图7:根据我们推荐样例项目

图 6 显示了用于回答用户的自由文本代码搜索查询的 BDA 屏幕截图。用户通过 How do I 界面输入如何保存图像的查询。请求被发送到 BDA 后端,从网页中提取的相关代码片段(在本例中为 Stack Overflow 中的代码片段)返回给用户。图 7 显示了推荐示例项目的屏幕截图。通过 BDA 的搜索框,用户可以进行自由文本查询(本例中为“.netcompiler”)并访问许多流行的开源项目站点,例如 GitHub 和 MSDN。图 7 显示了 BDA 检索项目,例如 .NET 编译器平台 Roslyn。为了便于重用,BDA 还可以将这些库拉入用户的 Visual Studio 环境中。

5.结论

在本文中,我们将介绍 Bing 开发助手 (BDA),该工具通过推荐从公共软件存储库(如 GitHub)和网页(如 Stack Overflow)中挖掘的 API 示例代码来帮助提高开发人员的工作效率。BDA 提供实现 API 或回答代码搜索查询的代码片段。使用 BDA,开发人员可以从 Visual Studio IDE 中查找和重用大量示例代码。

我们现在将 BDA 扩展为一项服务,并将其与其他 Microsoft 服务(如 . 通过 Bing 搜索,开发者可以获取 BDA 服务提供的各种编程语言的 API 示例代码。返回的示例代码显示在 Web 浏览器中。API 使用数据和示例代码也可供其他软件工程研究项目使用。Bing Development Assistant 的愿景是为开发人员提供技术帮助。目前它只支持 Visual Studio。我们将很快扩展到其他 IDE 生态系统。

参考

[1]

[2]

[3]

[4]

[5]

[6]

[7] Y. Wei 和 N. Chandrasekaran 以及 S. Gulwani 和 Y. Hamadi,Building Bing 开发人员助理,微软技术报告 MSR-TR-2015-36,201 年 5 月5.

谢谢

本文由南京大学软件学院2018级硕士袁阳阳翻译转录。 查看全部

网页源代码抓取工具(

一个名为Bing开发助手(BDA)的示例代码以学习如何解决与编程相关的问题)

引用:H. Zhang、A. Jain、G. Khandelwal、C. Kaushik、S. Ge、W. Hu,“Bing 开发人员助手:通过推荐示例代码提高开发人员生产力”,软件基础国际研讨会论文集工程,第 956-961 页,2016.

概括

在编程实践中,开发人员经常需要示例代码来学习如何解决与编程相关的问题。例如,如何重用大型软件库的应用程序编程接口(API),如何实现某个功能。我们相信,以前编写的代码可以帮助开发人员编写新程序,帮助他们了解其他人是如何解决类似问题的。我们开发了一个名为 Bing Development Assistant (BDA) 的工具,它通过推荐从公共软件存储库(如 GitHub)和网页(如 Stack Overflow)中挖掘的示例代码来提高开发人员的工作效率。BDA 可以自动挖掘实现 API 或回答代码搜索的代码片段。它是作为 Microsoft Visual Studio 的免费插件实现的,自 2014 年 12 月首次发布以来已获得超过 670K 的下载量。

1.简介

编程有时很难。在实践中,开发人员经常面临许多与解决问题相关的挑战。例如,开发人员经常想知道如何实现某个功能(例如,如何在 C# 中以 PNG 格式保存图像)。虽然 API(应用程序编程接口,如 .NET Framework 中的 Image.Save 和 Image.Tag 方法)提供了一种重要的软件重用形式并被广泛用于有效解决问题,但开发人员仍然需要知道“如何重用 API? ”。.NET 框架等大型软件框架可能收录数百甚至数千个 API。程序员通常不记得应该如何重用 API 函数。许多 API 也没有很好的文档记录。在 2009 年微软进行的一项调查中,67. 6% 的受访者表示学习 API 的资源不足或缺乏是一个障碍。除了 API 功能,开发人员可能还需要了解公共类、结构或属性的用法。因此,希望开发者遇到编程困难时,IDE提供API使用示例代码。

多年来,已经开发和部署了数百万个软件程序。这些程序的源代码通常存储在软件存储库(例如 GitHub)中,可以作为开发人员的重要可重用资产。以前编写的程序可以帮助开发人员了解其他人是如何解决类似问题的,并且可以作为编写新程序的基础。此外,Stack Overflow 等以开发人员为中心的在线问答 (QA) 论坛的出现为解决编程相关问题提供了丰富的资源(包括示例代码)。

许多现代集成开发环境(IDE,例如 Microsoft Visual Studio)为高效开发程序提供了丰富的功能。但是,大多数 IDE 不向开发人员提供示例代码。虽然开发人员可以使用 Bing 或 Google 等常规 Web 搜索引擎来查找解决方案,但他们通常需要经常离开 IDE 环境并在 IDE 和 Web 浏览器之间切换上下文。这会导致生产率降低。此外,某些网络搜索引擎可能无法很好地支持与编程相关的问题,例如使用某个 API。

我们开发了一种称为 Bing 开发助手 (BDA) 的工具,通过挖掘软件存储库和网页来帮助提高开发人员的工作效率。我们将 BDA 的后端部署为 Microsoft Azure 服务,并将前端实现为 Visual Studio 扩展。BDA 可以通过 Visual Studio 的 IntelliSense 功能自动检测当前编程上下文中正在编辑的 API,并提供收录 API 使用情况的示例代码。BDA 还利用 Bing 搜索引擎来支持基于自由文本的代码搜索查询。BDA 为示例解决方案提供本地入口,以更有效地完成任务。

目前,BDA 支持 C/C++/C# 语言。它在开发人员中很受欢迎。自 2014 年 12 月首次发布以来,它已吸引了超过 670,000 次下载。BDA 现在可在以下网址下载: 。我们还扩展了 BDA 以支持更多语言(如 Java 和 JavaScript)和更多用例。

2.从软件仓库获取示例代码

在本节中,我们描述了一个从软件存储库中提取 API 示例代码的框架。示例代码用于了解各种 API 的使用,包括公共类、函数、结构、属性等。图 1 显示了我们方法的一般框架。我们首先通过 网站 从 MSDN 和 GitHub 等中抓取源代码项目来构建大型软件存储库。存储库收录用不同语言编写的源文件,例如 C/C++/C#/Java。然后,我们利用 Clang[1](用于 C/C++)、Roslyn[2](用于 C#)和 JDT[3](用于 Java)等编译器来静态分析这些源文件并生成中间表示(抽象语法树) . 可以从 AST 中推断出 API 相关的源代码信息。生成的 API 使用数据,包括有关项目、文件、行等的信息,存储在 Azure 表 [4] 中。最后,可以提取相关示例代码使用(Visual Studio IDE等客户端)。特别是,我们开发了一个静态分析器,它将源代码文件解析为 AST,然后在访问每个 AST 节点时执行数据提取。分析器基于编译器前端(例如 Clang 的 LibTooling,一个用于公开 AST 的库)。这样我们就不需要任何 .dll 或 .so 文件或任何特定的运行时环境

图 1:从软件存储库中挖掘 API 使用情况

静态分析器使用的算法如图2所示:

图 2:提取 API 使用 d 的算法

它收录三个主要部分:第一个(Main)是将源代码文件解析成一个AST,第二个(Visit)是遍历AST中的节点,第三个(Process_*)是一组AST对应的不同类型的节点功能。给定源代码文件和头文件应该驻留的目录,分析器解析源代码文件和相关的头文件。源代码文件的 AST 和头文件的 AST 组合成一个大的 AST 作为中间表示。在生成组合的 AST 后,分析器执行 AST 的有序遍历。当分析器访问我们感兴趣的节点时,例如函数调用或变量声明,它会按类型进一步处理 AST 节点。在图 2 中,我们只展示了处理函数调用的伪代码。

我们使用一个 API 调用示例来说明该算法(图 3)。图 3 收录整个 AST 的片段,以及两个相应的源代码文件。当我们访问“ac”的节点时,我们发现一个节点实际上上面是一个函数调用——"foo(1)"。我们使用被调用者的标识符在头文件的AST节点中查找它的有效声明。结果,我们发现声明节点在“ah”是我们想要的。然后我们检查这个文件的来源。在这种情况下,“ah”文件与“ac”来自同一目录,因此我们将其标记为用户定义的API并记录下来以及“ac”中的源代码位置。

图 3:API 调用示例

我们面临的一个挑战是第 3 方库支持。这实际上体现在图 2 中的 Which_Library 函数中。我们需要知道 foo 来自哪个库 API。如果我们可以解决依赖关系(例如,在 C# 的情况下,它的依赖关系可以在 Nuget[5] 的帮助下解决),我们构建一个对列表。将源代码文件解析成AST,访问AST中的每个节点后,我们就可以提取出我们想知道的API,搜索对应的库名。

但是,在某些语言(如C/C++)中,由于项目的平台/环境设置,我们通常无法通过执行make文件来成功构建项目。解决所有项目依赖关系也不容易。由于缺乏相关的头文件,某些第三方库的缺乏使得识别第三方库的 API 更具挑战性。考虑图 3 中描述的情况,如果头文件“ah”丢失,我们只知道 foo 是一个函数调用语句,但我们不知道函数在哪里声明。在这种情况下,我们将无法编译源代码文件。

BDA 支持常用第三方库的列表。我们使用 Nuget 和 GitHub 来选择最流行的第三方库(例如,我们为 C/C++ 选择了 1200 个流行的库),这些库被开发者社区广泛使用。我们还生成了一个对列表,其中 libname 代表第三方库的名称,path 代表头文件的确切路径。在程序分析期间,我们获得了被分析的 API 的路径,并

在列表中搜索。这样,即使我们无法成功构建项目,也可以获得API所属的第3方库。

处理完软件仓库中的所有项目后,我们得到API使用数据(包括API名称、所属库、项目、文件、行号等信息)。我们将此数据存储在 Microsoft Azure 表中。根据数据的用途,可以针对各种应用场景轻松检索 API 的示例代码

在 BDA 客户端中,我们侦听 Visual Studio 的 IntelliSense[6] 接口以获取正在编辑的程序的上下文。IntelliSense 接口可以自动为开发人员提供可在当前编程上下文中使用的 API 列表。此类 API 信息用于在 Visual Studio 环境中触发我们的 BDA 示例代码服务。

3.从 Bing 搜索引擎获取解决方案

为了帮助开发者了解如何实现某个功能,我们将代码搜索组件集成到开发者助手中。开发人员可以输入描述问题的自然语言查询(例如,如何保存图像)。BDA 可以使用 Bing 搜索引擎 ( ) 自动调用网络搜索并从返回的网页(例如 Stack Overflow 和 MSDN 网页)中获取相关片段。图 4 显示了使用 Bing 进行挖掘的示例代码的总体框架

图 4:使用 Bing 挖掘示例代码

给定用户查询,BDA 首先通过附加当前编程上下文中使用的编程语言来扩展原创查询(例如“如何在 c# 中保存图像”)。然后它会调用 Bing 搜索引擎来查找与该查询相关的网页。在检索到前 10 个网页后,BDA 识别并从 HTML 页面中提取代码(基于 HTML 标签,如 hprei、hcodei、hpi 和 hdivi)。BDA 还根据相关性和投票/接受的数量对提取的片段进行排名,并将它们显示在 Visual Studio 环境中。这样,用户无需启动单独的 Web 浏览器即可执行代码搜索查询。我们的用户研究表明,每个查询的平均响应时间为 1.5 秒,提供流畅的用户体验。关于 BDA 代码搜索功能的更多细节可以在 [7] 中找到。

除了提供代码片段外,BDA 还支持基于用户查询的示例商品推荐。代码示例项目是开发人员可以下载、构建和运行的完整 Visual Studio 解决方案。收到用户查询后,BDA 可以调用 Bing 搜索引擎从 MSDN 和 GitHub 等站点检索最相关的项目。项目信息(如项目 URL、作者、许可证、评级等)将被提取并显示在 Visual Studio 环境中。通过重用整个解决方案可以提高开发人员的工作效率。

BDA 还可以提供编译错误的解决方案。使用 Visual Studio 编译程序时发生编译错误后,用户只需右键单击并调用上下文搜索即可。BDA 客户端将提取当前上下文(例如错误代码/消息、项目类型、数据类型、正在使用的编程语言等)。然后,它将上下文发送给后端服务,后端服务将从上下文中提取相关功能,生成上下文查询,并调用必应搜索引擎获取编译错误的示例解决方案,并将获取的示例代码返回给用户。例如,假设我们正在编辑一个 C++ 程序并使用“std::string”类来存储“hello world”字符串。如果我们忘记收录头文件“字符串”,Visual Studio 将报告错误消息,如“ string' 不是 'std' 的成员。这个消息可能会让一些新开发者感到困惑。BDA 可以通过提供示例解决方案来帮助他们。错误消息和其他上下文信息会自动组合以形成一个查询,该查询将传递给 BDA 后端服务以进行 Bing 搜索。Bing 搜索结果(在本例中为有关解决相同编译问题的 Stack Overflow 页面)将返回并显示在 Visual Studio 中。

4.工具实现

为了从源代码存储库中获取有关 API 使用的示例代码,我们通过从 MSDN 和 GitHub 上抓取项目来构建一个大规模的代码库。为了移除虚拟项目,对于 GitHub,我们只抓取至少有一颗星的项目。我们总共抓取了 65,253 个项目。这些项目的总大小约为 437 GB,收录约 350 万个源代码文件。表 1 显示了所得结果的统计数据。

API 使用数据和示例代码存储在世界各地的许多 Microsoft Azure 服务器中。索引和检索过程由 Microsoft Azure Table 执行。客户端是一个支持Microsoft Visual Studio (2012-2016)的扩展。我们挂钩到Visual Studio的IntelliSense接口来获取正在编辑的程序的上下文。IntelliSense提供的API触发后端BDA服务。返回API 示例代码将自动从 Azure 服务器获取并显示在 Visual Studio 中。

图 5:推荐 API 示例代码

图 5 显示了 BDA Recommendation API 示例代码的屏幕截图。当用户键入不完整的 API 时,Visual Studio(通过其 IntelliSense 功能)将推荐候选 API 列表。如果用户不知道如何使用这些 API,可以在 Visual Studio 环境中查看 BDA 返回的示例代码。在图 5 中,用户输入了一个不完整的 API 'doc.l...',BDA 自动推荐候选函数 'Load' 的代码片段。

目前,BDA 提供了通过 Bing 搜索从各种网站 中采集的示例代码/项目。这些 网站 包括 Stack Overflow、dotnetperls、C#411、Cppreference 和 MSDN。表 2 显示了截至 2016 年 6 月从两个流行的软件论坛(Stack Overflow 和 MSDN)获得的代码片段总数。

图 6:根据用户 q 推荐示例代码

图7:根据我们推荐样例项目