无规则采集器列表算法

数据采集分析工程师

采集交流 • 优采云 发表了文章 • 0 个评论 • 248 次浏览 • 2020-08-27 18:42

5、编写剖析,采集文档,提出合理化采集方案;

6、采集行业各种信息,并整理、汇总产生基础信息库,为剖析、决策提供支撑。

7、设计爬虫策略和防屏蔽规则,提升网页抓取的效率和质量;

8、负责分布式爬虫策略持续优化。

任职要求:

1、 熟悉Linux开发环境;熟练把握JAVA,C#等语言;基础扎实,熟悉多线程、高并发编程,代理技术、网络编程技术,熟悉分布式、缓存、消息、搜索等机;

2、 对TCP/IP和HTTP合同有较深的理解,熟悉网页抓取原理及技术,熟悉HTTP合同,熟悉基于Cookie,Session的网站登录原理,熟悉基于正则表达式、Xpath、CSS等网页信息抽取技术;

3、 具备信息检索、web挖掘等搜索引擎相关知识,有从事海量网路爬虫、反爬技术,深度抓取、动态网页抓取技术、浏览器模拟抓取技术、从结构化的和非结构化数据中获取信息

4、 具备图象处理技术, 熟悉Tesseract-ocr,对图片文件中的文字进行剖析辨识如验证码文字的提取与辨识

5、熟悉和应用过常用的数据剖析建模,数据挖掘、机器学习算法,如:聚类剖析,关联规则,决策树,回归剖析,时间序列等;

6、 具备良好的沟通能力和管理能力;

7、具有5年以上.NET(C#)商业项目开发经验。

8、 大学本科以上学历,计算机相关专业。 查看全部

数据采集分析工程师

5、编写剖析,采集文档,提出合理化采集方案;

6、采集行业各种信息,并整理、汇总产生基础信息库,为剖析、决策提供支撑。

7、设计爬虫策略和防屏蔽规则,提升网页抓取的效率和质量;

8、负责分布式爬虫策略持续优化。

任职要求:

1、 熟悉Linux开发环境;熟练把握JAVA,C#等语言;基础扎实,熟悉多线程、高并发编程,代理技术、网络编程技术,熟悉分布式、缓存、消息、搜索等机;

2、 对TCP/IP和HTTP合同有较深的理解,熟悉网页抓取原理及技术,熟悉HTTP合同,熟悉基于Cookie,Session的网站登录原理,熟悉基于正则表达式、Xpath、CSS等网页信息抽取技术;

3、 具备信息检索、web挖掘等搜索引擎相关知识,有从事海量网路爬虫、反爬技术,深度抓取、动态网页抓取技术、浏览器模拟抓取技术、从结构化的和非结构化数据中获取信息

4、 具备图象处理技术, 熟悉Tesseract-ocr,对图片文件中的文字进行剖析辨识如验证码文字的提取与辨识

5、熟悉和应用过常用的数据剖析建模,数据挖掘、机器学习算法,如:聚类剖析,关联规则,决策树,回归剖析,时间序列等;

6、 具备良好的沟通能力和管理能力;

7、具有5年以上.NET(C#)商业项目开发经验。

8、 大学本科以上学历,计算机相关专业。

定稿亲稳网络舆情监控系统项目投资可研商业计划书最终初稿(模版2)

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2020-08-27 09:41

1、统动提取。)结构化采集技术数安舆情监控系统对网页数据进行结构化信息抽取和数据储存,以满足多维度信息挖掘和统计须要。)全天候不间断监控数安舆情监控系统*全天候监控互联网信息,也可设定采集时间;实施中可以做到分钟级采集更新。)采集信息预处理数安舆情监控系统系统对采集信息进行系列预处理操作:超链剖析、编码辨识、URL去重、锚文本处理、垃。

2、名称提供便捷。)相似性检索和查重技术基于文档“指纹”文本查重技术,支持海量数据信息查重。相似性检索是在文本集合中查找出与之内容相像其他文本技术。在实际应用中找出舆情信息内容雷同文章,对相像、雷同文章消重处理;还依据文章主题相似性,生成专题报导,背景剖析等。自然语言智能处理技术)自动分词技术以辞典为基础,规则与统计相结合动词技术,有。

3、通过内容相关辨识技术手动判断分类中文章关系,如果发觉描述相同风波文章自动消除重复部份。热点话题、敏感话题辨识可以按照新闻出处权威度、发言时间密集程度等参数,识别出给定时间段内热门话题。利用内容主题单词和回帖数进行综合语义剖析,识别敏感话题。舆情主题跟踪剖析新发表文章、贴子话题是否与已有主题相同。自动摘要对各种主题,各类倾向才能产生。

4、内容进行直接采集,只须要输入搜索关键词就可以了。支持内容抽取辨识系统可对网页进行内容剖析和过滤,自动清除广告、版权、栏目等无用信息,精确获取目标内容主体。基于内容相似性去重通过内容相关辨识技术手动判断分类中文章关系,如果发觉描述相同风波文章自动消除重复部份。热点话题、敏感话题辨识可以按照新闻出处权威度、发言时间密集程度等参数,识别。

5、信息过滤、关键字抽取、关键信息提取、正文抽取、自动摘要,达到系统舆情智能剖析前状态。数安舆情监控系统舆情智能剖析技术)自动分类技术手动分类技术包括以下两中分类方法:A基于内容文本自动分类B基于规则文本分类)自动聚类技术基于相似性算法手动降维技术,自动对海量无规则文档进行归类,把内容相仿文档归为一类,并手动为其生成主题词,为确定类目。

6、效解决切分歧义。综合运用基于机率统计语言模型方式,分词准确性达到。)自动关键词和手动摘要技术对采集到网路信息,自动摘取相关关键字,并生成摘要,并与快速浏览与检索。全文检索技术全文检索将传统全文检索技术与最新WEB搜索技术相结合,大大提高检索引擎性能指标。还融合多种技术,提供丰富检索手段以及同义词等智能检索方法。第三章施行方案总体框。

7、从整体结构上看,实现舆情剖析预警起码应包括:数据信息采集、统计挖掘预测、结果展示三个阶段。(如图)图舆情剖析预警系统系统结构数安舆情监控系统系统特性自定义URL来源及采集频率可以设定采集栏目、URL、更新时间、扫描间隔等,系统扫描间隔最小可以设置成分钟,即每隔一分钟,系统将手动扫描目标信息源,以便及时发觉目标信息源最新变化,并以最。

8、快速率采集到本地。支持多种网页格式可以采集常见静态网页(HTMLH),还可以采集网页中收录图片信息。支持多种字符集编码系采集子系统才能手动辨识多种字符集编码,包括英文、英文、中文繁体、中文简体等,并可以统一转换为GBK编码格式。支持整个互联网采集舆情检测系统搜索模式是以国外著名互联网搜索引擎结果为基础并借助采集器直接面向互联网订制。

9、动性;)深度文字挖掘,实现对结构化、半结构化、非机构化数据文字挖掘须要;)强大数理统计功能,丰富详实统计数据,是完善决策机制不可或缺打算;)智能内容管理,高效管理网路舆情和内部文件;)及时自主发觉热点信息,健全危机风波预警机制防范于未然。第四章项目投资序号名称单位价钱数安网路数安舆情监控系统套信息。)信息智能提取技术数安舆情监控系。

10、后生成报告,可通过浏览器浏览,提供信息检索功能,根据指定条件对热点话题、倾向性进行查询,并浏览信息具体内容,提供决策支持。价值实现数安舆情监控系统为实现以下价值目标:)实现对海量网路信息之分类舆情采集;)实现第一时间把握网络舆情最新动态;)智能化信息剖析流程,流水线作业,提升信息加工效率;)极大解放人工于重复工作,充分发挥人主观能。

11、给定时间段内热门话题。利用内容主题单词和回帖数进行综合语义剖析,识别敏感话题。舆情主题跟踪剖析新发表文章、贴子话题是否与已有主题相同。自动摘要对各种主题,各类倾向才能产生手动摘要。舆MSHTML)和动态网页(ASPPHPJSP),还可以采集网页中收录图片信息。支持多种字符集编码系采集子系统才能手动辨识多种字符集编码,包括英文、英文 。

12、、中文繁体、中文简体等,并可以统一转换为GBK编码格式。支持整个互联网采集舆情检测系统搜索模式是以国外著名互联网搜索引擎结果为基础并借助采集器直接面向互联网订制内容进行直接采集,只须要输入搜索关键词就可以了。支持内容抽取辨识系统可对网页进行内容剖析和过滤,自动清除广告、版权、栏目等无用信息,精确获取目标内容主体。基于内容相似性去重 查看全部

定稿亲稳网络舆情监控系统项目投资可研商业计划书最终初稿(模版2)

1、统动提取。)结构化采集技术数安舆情监控系统对网页数据进行结构化信息抽取和数据储存,以满足多维度信息挖掘和统计须要。)全天候不间断监控数安舆情监控系统*全天候监控互联网信息,也可设定采集时间;实施中可以做到分钟级采集更新。)采集信息预处理数安舆情监控系统系统对采集信息进行系列预处理操作:超链剖析、编码辨识、URL去重、锚文本处理、垃。

2、名称提供便捷。)相似性检索和查重技术基于文档“指纹”文本查重技术,支持海量数据信息查重。相似性检索是在文本集合中查找出与之内容相像其他文本技术。在实际应用中找出舆情信息内容雷同文章,对相像、雷同文章消重处理;还依据文章主题相似性,生成专题报导,背景剖析等。自然语言智能处理技术)自动分词技术以辞典为基础,规则与统计相结合动词技术,有。

3、通过内容相关辨识技术手动判断分类中文章关系,如果发觉描述相同风波文章自动消除重复部份。热点话题、敏感话题辨识可以按照新闻出处权威度、发言时间密集程度等参数,识别出给定时间段内热门话题。利用内容主题单词和回帖数进行综合语义剖析,识别敏感话题。舆情主题跟踪剖析新发表文章、贴子话题是否与已有主题相同。自动摘要对各种主题,各类倾向才能产生。

4、内容进行直接采集,只须要输入搜索关键词就可以了。支持内容抽取辨识系统可对网页进行内容剖析和过滤,自动清除广告、版权、栏目等无用信息,精确获取目标内容主体。基于内容相似性去重通过内容相关辨识技术手动判断分类中文章关系,如果发觉描述相同风波文章自动消除重复部份。热点话题、敏感话题辨识可以按照新闻出处权威度、发言时间密集程度等参数,识别。

5、信息过滤、关键字抽取、关键信息提取、正文抽取、自动摘要,达到系统舆情智能剖析前状态。数安舆情监控系统舆情智能剖析技术)自动分类技术手动分类技术包括以下两中分类方法:A基于内容文本自动分类B基于规则文本分类)自动聚类技术基于相似性算法手动降维技术,自动对海量无规则文档进行归类,把内容相仿文档归为一类,并手动为其生成主题词,为确定类目。

6、效解决切分歧义。综合运用基于机率统计语言模型方式,分词准确性达到。)自动关键词和手动摘要技术对采集到网路信息,自动摘取相关关键字,并生成摘要,并与快速浏览与检索。全文检索技术全文检索将传统全文检索技术与最新WEB搜索技术相结合,大大提高检索引擎性能指标。还融合多种技术,提供丰富检索手段以及同义词等智能检索方法。第三章施行方案总体框。

7、从整体结构上看,实现舆情剖析预警起码应包括:数据信息采集、统计挖掘预测、结果展示三个阶段。(如图)图舆情剖析预警系统系统结构数安舆情监控系统系统特性自定义URL来源及采集频率可以设定采集栏目、URL、更新时间、扫描间隔等,系统扫描间隔最小可以设置成分钟,即每隔一分钟,系统将手动扫描目标信息源,以便及时发觉目标信息源最新变化,并以最。

8、快速率采集到本地。支持多种网页格式可以采集常见静态网页(HTMLH),还可以采集网页中收录图片信息。支持多种字符集编码系采集子系统才能手动辨识多种字符集编码,包括英文、英文、中文繁体、中文简体等,并可以统一转换为GBK编码格式。支持整个互联网采集舆情检测系统搜索模式是以国外著名互联网搜索引擎结果为基础并借助采集器直接面向互联网订制。

9、动性;)深度文字挖掘,实现对结构化、半结构化、非机构化数据文字挖掘须要;)强大数理统计功能,丰富详实统计数据,是完善决策机制不可或缺打算;)智能内容管理,高效管理网路舆情和内部文件;)及时自主发觉热点信息,健全危机风波预警机制防范于未然。第四章项目投资序号名称单位价钱数安网路数安舆情监控系统套信息。)信息智能提取技术数安舆情监控系。

10、后生成报告,可通过浏览器浏览,提供信息检索功能,根据指定条件对热点话题、倾向性进行查询,并浏览信息具体内容,提供决策支持。价值实现数安舆情监控系统为实现以下价值目标:)实现对海量网路信息之分类舆情采集;)实现第一时间把握网络舆情最新动态;)智能化信息剖析流程,流水线作业,提升信息加工效率;)极大解放人工于重复工作,充分发挥人主观能。

11、给定时间段内热门话题。利用内容主题单词和回帖数进行综合语义剖析,识别敏感话题。舆情主题跟踪剖析新发表文章、贴子话题是否与已有主题相同。自动摘要对各种主题,各类倾向才能产生手动摘要。舆MSHTML)和动态网页(ASPPHPJSP),还可以采集网页中收录图片信息。支持多种字符集编码系采集子系统才能手动辨识多种字符集编码,包括英文、英文 。

12、、中文繁体、中文简体等,并可以统一转换为GBK编码格式。支持整个互联网采集舆情检测系统搜索模式是以国外著名互联网搜索引擎结果为基础并借助采集器直接面向互联网订制内容进行直接采集,只须要输入搜索关键词就可以了。支持内容抽取辨识系统可对网页进行内容剖析和过滤,自动清除广告、版权、栏目等无用信息,精确获取目标内容主体。基于内容相似性去重

网站避免被百度惩罚降权,2018百度排行规则及算法汇总

采集交流 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2020-08-26 12:51

俗话说的好要想百度排行好未能就三种,第一你给百度钱了,第二你是百度旗下的公司或产品,第三你提供有价值的内容,提高了百度搜索的用户体验了。除去这三个理由,你别想着要百度给你排行,那么泽民就围绕这三种理由,给你们展开剖析。

百度竞价

百度竞价主要是依据关键词出价获得排行的,对于百度竞价我了解的不是好多,大致我知道,当你出价5元一个点击,排名在第三位,那么人家想要超过你,人家就得出价5元以上,原理是这个样子的。

通常情况下,百度付费的广告排行控制在第2-3是最好的状态,排名在第一,基本是竞争对手在点击你的网站。所以控制在2-3是最佳的位置。

百度竞价最大的益处,就是排行时间块,马上投放广告,马上就有排行,所以不少的企业选择百度竞价做前期推广,而百度竞价的原理也十分简单,百度公司要挣钱生存,所以推出了这个百度付费推广的模式,通过她们的后台直接操作给你排行,你有排行可以赚到钱,但你得给她们钱,不可能永远借助百度竞价来支撑,所以不仅百度竞价,我们还可以这样去做。

百度旗下产品

百度旗下产品特别多,能够参与排行的也特别多,比如百度文库、百度知道、百度百科、百度经验、百度百家等等,这些百度产品只是一个平台,百度官方人员从来不会编辑上面的内容,这些平台上面的内容都是由第三方企业或个人编辑而成,既然要我们来编辑,那么推广的机会就来了。咱们还是先谈谈,他们排名算法以及规则吧。

百度旗下的产品是由百度自己开发而成,在排行上有很大的优势,优势在那里呢,就是通过阿拉丁通道排行的,说白了就是走后门。

前面说到了付费竞价推广是通过后台直接给出排行,而百度旗下产品的平台与付费推广不一样,他们不属于推广,而是直接优先展示她们网站的排行。展现的方式还是与普通网站自然排行诠释的方式一样。

但是这些阿拉丁通道的排行也是有规则的,第一她们没有收录规则,基本是初审通过的内容直接收录,所以收不收录就看你的内容是否会初审。但是她们的排行是有规则的,也的依据需求来,能够参与排行的缘由,是因为太多人有这个需求。

其次就是百度的阿拉丁通道了,论权重新浪、搜狐等小型网站不比百度经验差,但是百度为了使自己旗下产品生存,获得流量,只有通过侧门技术,直接用百度经验的页面来做排行。之所以给百度经验排行也不给原创博客的我,原因是我的博客目前来讲信誉度不够,也就是也称的权重不够。

百度免费排行

百度免费排行是你们最关心的事情了,因为俺不是百度家的亲人,也不是土豪玩家,所以在其他两个方面,我们没有优势,只有选择百度免费排行了,百度免费排行的规则和算法也是最多的,最麻烦的一件事情,总体还是围着信誉度(权重)展开的。这个信誉度从综合诱因判定,并非单一的优势。

百度收录规则

要想有排行的前提下是收录,要向收录的前提下是有内容,所以好多网站内容很单一是很难被收录,但也有网站明显有内容就是不收录的,我是这样理解收录的。

抓取:百度收录一个网站或页面的前提是网站被百度抓取过,也就是百度的机器来过你的站点,来你站点的前提是有一个入口,百度的入口有三个,第一自己递交、第二SEO外链、第三浏览器。浏览器你们可能不是太明白,当你的网站刚刚完善后,没有人知道你的建站构建好了,自然百度也不会晓得,唯一晓得的就是你自己了,如果你使用百度浏览器打开你的网站,这也就意味着,百度浏览器早已晓得了这个站点的存在,数据也就交给了百度搜索引擎,从而达到了抓取的疗效。光抓取还是不够的,不一定所有的内容还会被百度收录,所以她们收录也是要判别内容标准。

识别:抓取了一个页面,肯定是有内容的,如果说没有内容是很难被收录的,什么是没有内容的页面呢,比如登入注册页面,这类页面是属于有内容没有意义的页面。直接会被纳入到空白页面,想这类页面,我们的网站还是十分多的,比如:关于我们、联系我们之类的页面。

所以页面肯定得有内容,并且是可辨识的内容,什么叫可辨识的内容,就是文字内容,百度搜索引擎是机器在辨识,当遇见视频、图片、flash的时侯,他们不知道视频、图片上面诠释的内容是哪些,所以难以辨识,所以前期最好还是以文字为主。

释放:最终才考虑到释放下来,如果释放下来后,这个时侯你可以通过百度搜索你的URL,释放你的页面也是须要有条件的。

首先会判定你的页面站外推荐好多,这也就意味着这个页面是高质量的页面就会被站外推荐,容易被收录,其次是被站内推荐,这也意味着是这个页面是高质量页面就会被站内推荐。说白了,要向释放下来的内容,绝对是高质量的内容,除非发生了下边此类情况。

最容易被收录的内容绝对是互联网新闻源最多的内容,说白了就是抄袭者好多的内容是最容易被收录的。这个时侯太多人不容易理解了,抄袭越多越容易被收录?

新闻内容是具有时效性的,当一篇新闻发布之后,马上就有好多媒体转载你的内容,而百度机器辨识下来,很多新闻源有同样的内容,也就被纳入了新闻的话题页面,从而这方面的内容收录也就十分简单了,不会等三天或几天后才收录,如果过几天才收录,这个新闻内容早已过时了,自然也就影响了百度的体验。

排名规则

参与排行的规则并没有你们想像中这么复杂,其实无非就几个方面解决排行问题。

得分规则:得分规则是按照一个网站的总体信誉度,比如网站的原创度、网站的逗留时间、网站的跳出率、网站的打开速率、网站图片的处理、网站代码的优化等综合判定,总体被称为得分规则。

点击规则:

当你网站信誉度达到一个基础标准后,你网站会出现一些长尾关键词,可能关键词排行并没有在首页,这个时侯就是按照点击率的规则来估算排行的。如下图所示,当一个关键词展现量和点击率达到一个比列后,你的排行都会上前一个等级。而这个比列是按照用户的点击来估算的,并非百度定义的,点击率越高这个关键词排行就越好,那么百度点击算法是如何回事尼?

链接规则:

当你的一篇文章被站外链接过多推荐,这意味着这篇文章价值十分大,不然对方不会推荐,另外也被站内推荐多次,这也意味着这篇文章价值十分大,所以链接的规则就十分简单的,但是因为百度绿萝算法仍然在严打垃圾外链,所以在链接上,最好还是自然链接比较安全。

百度算法规则

本不相信百度的算法有那样的神奇,但是百度确针对这一系列的算法作出了公告与K站降权的举动,不得不使我仔细剖析百度算法的原理,以下几个算法仅为我个人猜测。

百度绿萝算法:

我始终不相信百度绿萝算法居然可以算下来你的链接是否订购的,但是实际百度却做到了,其中主要原理还是按照一个网站对另一个网站的链接判定,是否有反向链接、链接个数来进行判定。

百度石榴算法:

石榴算法主要严打的对象为低质量页面,其中百度蜘蛛主要是依据网站html代码来抓取的,并且搜索引擎依据文章的标签(收录排版)、重复读来进行判定网站的质量。

百度星火计划:

星火计划的原计划是为了严打抄袭者,其星火计划的原理十分简单了,也就是判定重复读来决定网站是否剽窃,同时百度蜘蛛也肯定了自己的抓取程序,目前正在往每一个网站时刻爬取靠拢。

百度惊雷算法:

百度惊雷算法严厉严打通过刷点击,提升网站搜索排序的作弊行为;以此保证搜索用户体验,促进搜索内容生态良性发展。

百度冰桶算法:

百度移动搜索将针对低质站点及页面进行一系列调整,我们称之为冰桶算法。影响范围:强行弹窗app下载、用户登入、大面积广告等影响用户正常浏览体验的页面,尤其以必须下载app能够正常使用的站点为代表。从整个联通互联网生态环境看,越来越多的网站进行这种强推,这早已严重影响了正常用户的浏览体验。

百度优采云算法:

优采云算法,是百度搜索引擎针对新闻源站点售卖软文、目录等严重违背新闻源规则,并影响用户搜索体验行为,于2016年11月即将启用的一种搜索引擎算法规则,其目的是严厉严打新闻源售卖软文、目录行为,还用户一片搜索优采云。

百度天网算法:

天网算法主要是针对网页搜索发觉部份站点存在窃取用户隐私的行为进行严打。主要表现为网页嵌恶意代码(多为JS代码),用于窃取网民的QQ号、手机号。

百度飓风算法:

百度搜索于近期推出飓风算法,旨在严厉严打以恶劣采集为内容主要来源的网站,同时百度搜索将从索引库中彻底消除恶劣采集链接,给优质原创内容提供更多展示机会,促进搜索生态良性发展。

飓风算法会例行产出惩罚数据,同时会按照情况随时调整迭代,体现了百度搜索对恶劣采集的零容忍。优质原创站点如发觉站点索引量急剧降低且流量急剧下降现象,可在反馈中心进行反馈。

百度清风算法:

百度搜索将于9月底推出清风算法,旨在惩处网站通过网页标题作弊,欺骗用户并获得点击的行为;从而保证搜索用户体验,促进搜索生态良性发展。

百度闪电算法:

关于百度上线 “闪电算法”的公告2017年10月初,“闪电算法”上线,移动搜索页面首屏加载时间将影响搜索排名。移动网页首屏在2秒之内完成打开的,在联通搜索下将获得提高页面评价优待,获得流量倾斜;同时,在联通搜索页面首屏加载特别慢(3秒及以上)的网页将会被打压。

【算法颁布时间:2018年4月19日】

【清风算法2.0】—严厉严打误导下载,主要严打以下两种类型:

1.实际下载的资源与需求不符;

2.提供了下载链接、实际站点无下载资源。

清风算法2.0,对于误导用户下载的问题进行永久封禁。

【算法颁布时间:2018年5月17日】

【烽火算法2.0】—严厉严打恶意绑架惩处,“窃取用户数据”和“恶意绑架”的行为。

主要针对:

1.未经用户准许恶意盗用用户手机号码等隐私数据的行为;

2.恶意绑架百度流量的行为(返回上一级页面被绑架到虚假的百度搜索结果页中或则网站站内)。

【算法颁布时间:2018年5月23日】

【惊雷算法2.0】—对“恶意制造作弊超链”和“恶意刷点击”的作弊行为进行算法升级,相对于炸雷算法1.0。 这次升级主要针对“恶意制造作弊超链”和“恶意刷点击”的作弊行为进行了算法升级。惊雷算法2.0将对作弊的网站限制搜索诠释、清洗作弊链接、清洗点击,并会将站点作弊行为记入站点历史,严重者将永久封禁。

【算法颁布时间:2018年5月31日】

【极光算法】—倡导注重落地页时间规范

落地页时间因子是百度搜索判定网站收录、展示、排序结果的重要参考根据。

为了使用户获得更满意的搜索浏览体验,搜索引擎将给与符合落地页时间因子要求且时效性较高的网页更多的收录、展现机会,同时降低不符合规定的网站的诠释机会。

【算法颁布时间:2018年6月7日】

【季风算法】—重点严打违背熊掌号专注度要求的熊掌号。

百度提倡熊掌号领域专注度,对于违背熊掌号领域专注度要求的熊掌号将重点严打。

如有新算法颁布,会持续更新此报告,敬请关注!

总结:

不管算法规则如何更新,百度不变的是为了用户体验,所以我们在优化的时侯优先考虑用户体验,以用户为中心构建用户需求。 查看全部

网站避免被百度惩罚降权,2018百度排行规则及算法汇总

俗话说的好要想百度排行好未能就三种,第一你给百度钱了,第二你是百度旗下的公司或产品,第三你提供有价值的内容,提高了百度搜索的用户体验了。除去这三个理由,你别想着要百度给你排行,那么泽民就围绕这三种理由,给你们展开剖析。

百度竞价

百度竞价主要是依据关键词出价获得排行的,对于百度竞价我了解的不是好多,大致我知道,当你出价5元一个点击,排名在第三位,那么人家想要超过你,人家就得出价5元以上,原理是这个样子的。

通常情况下,百度付费的广告排行控制在第2-3是最好的状态,排名在第一,基本是竞争对手在点击你的网站。所以控制在2-3是最佳的位置。

百度竞价最大的益处,就是排行时间块,马上投放广告,马上就有排行,所以不少的企业选择百度竞价做前期推广,而百度竞价的原理也十分简单,百度公司要挣钱生存,所以推出了这个百度付费推广的模式,通过她们的后台直接操作给你排行,你有排行可以赚到钱,但你得给她们钱,不可能永远借助百度竞价来支撑,所以不仅百度竞价,我们还可以这样去做。

百度旗下产品

百度旗下产品特别多,能够参与排行的也特别多,比如百度文库、百度知道、百度百科、百度经验、百度百家等等,这些百度产品只是一个平台,百度官方人员从来不会编辑上面的内容,这些平台上面的内容都是由第三方企业或个人编辑而成,既然要我们来编辑,那么推广的机会就来了。咱们还是先谈谈,他们排名算法以及规则吧。

百度旗下的产品是由百度自己开发而成,在排行上有很大的优势,优势在那里呢,就是通过阿拉丁通道排行的,说白了就是走后门。

前面说到了付费竞价推广是通过后台直接给出排行,而百度旗下产品的平台与付费推广不一样,他们不属于推广,而是直接优先展示她们网站的排行。展现的方式还是与普通网站自然排行诠释的方式一样。

但是这些阿拉丁通道的排行也是有规则的,第一她们没有收录规则,基本是初审通过的内容直接收录,所以收不收录就看你的内容是否会初审。但是她们的排行是有规则的,也的依据需求来,能够参与排行的缘由,是因为太多人有这个需求。

其次就是百度的阿拉丁通道了,论权重新浪、搜狐等小型网站不比百度经验差,但是百度为了使自己旗下产品生存,获得流量,只有通过侧门技术,直接用百度经验的页面来做排行。之所以给百度经验排行也不给原创博客的我,原因是我的博客目前来讲信誉度不够,也就是也称的权重不够。

百度免费排行

百度免费排行是你们最关心的事情了,因为俺不是百度家的亲人,也不是土豪玩家,所以在其他两个方面,我们没有优势,只有选择百度免费排行了,百度免费排行的规则和算法也是最多的,最麻烦的一件事情,总体还是围着信誉度(权重)展开的。这个信誉度从综合诱因判定,并非单一的优势。

百度收录规则

要想有排行的前提下是收录,要向收录的前提下是有内容,所以好多网站内容很单一是很难被收录,但也有网站明显有内容就是不收录的,我是这样理解收录的。

抓取:百度收录一个网站或页面的前提是网站被百度抓取过,也就是百度的机器来过你的站点,来你站点的前提是有一个入口,百度的入口有三个,第一自己递交、第二SEO外链、第三浏览器。浏览器你们可能不是太明白,当你的网站刚刚完善后,没有人知道你的建站构建好了,自然百度也不会晓得,唯一晓得的就是你自己了,如果你使用百度浏览器打开你的网站,这也就意味着,百度浏览器早已晓得了这个站点的存在,数据也就交给了百度搜索引擎,从而达到了抓取的疗效。光抓取还是不够的,不一定所有的内容还会被百度收录,所以她们收录也是要判别内容标准。

识别:抓取了一个页面,肯定是有内容的,如果说没有内容是很难被收录的,什么是没有内容的页面呢,比如登入注册页面,这类页面是属于有内容没有意义的页面。直接会被纳入到空白页面,想这类页面,我们的网站还是十分多的,比如:关于我们、联系我们之类的页面。

所以页面肯定得有内容,并且是可辨识的内容,什么叫可辨识的内容,就是文字内容,百度搜索引擎是机器在辨识,当遇见视频、图片、flash的时侯,他们不知道视频、图片上面诠释的内容是哪些,所以难以辨识,所以前期最好还是以文字为主。

释放:最终才考虑到释放下来,如果释放下来后,这个时侯你可以通过百度搜索你的URL,释放你的页面也是须要有条件的。

首先会判定你的页面站外推荐好多,这也就意味着这个页面是高质量的页面就会被站外推荐,容易被收录,其次是被站内推荐,这也意味着是这个页面是高质量页面就会被站内推荐。说白了,要向释放下来的内容,绝对是高质量的内容,除非发生了下边此类情况。

最容易被收录的内容绝对是互联网新闻源最多的内容,说白了就是抄袭者好多的内容是最容易被收录的。这个时侯太多人不容易理解了,抄袭越多越容易被收录?

新闻内容是具有时效性的,当一篇新闻发布之后,马上就有好多媒体转载你的内容,而百度机器辨识下来,很多新闻源有同样的内容,也就被纳入了新闻的话题页面,从而这方面的内容收录也就十分简单了,不会等三天或几天后才收录,如果过几天才收录,这个新闻内容早已过时了,自然也就影响了百度的体验。

排名规则

参与排行的规则并没有你们想像中这么复杂,其实无非就几个方面解决排行问题。

得分规则:得分规则是按照一个网站的总体信誉度,比如网站的原创度、网站的逗留时间、网站的跳出率、网站的打开速率、网站图片的处理、网站代码的优化等综合判定,总体被称为得分规则。

点击规则:

当你网站信誉度达到一个基础标准后,你网站会出现一些长尾关键词,可能关键词排行并没有在首页,这个时侯就是按照点击率的规则来估算排行的。如下图所示,当一个关键词展现量和点击率达到一个比列后,你的排行都会上前一个等级。而这个比列是按照用户的点击来估算的,并非百度定义的,点击率越高这个关键词排行就越好,那么百度点击算法是如何回事尼?

链接规则:

当你的一篇文章被站外链接过多推荐,这意味着这篇文章价值十分大,不然对方不会推荐,另外也被站内推荐多次,这也意味着这篇文章价值十分大,所以链接的规则就十分简单的,但是因为百度绿萝算法仍然在严打垃圾外链,所以在链接上,最好还是自然链接比较安全。

百度算法规则

本不相信百度的算法有那样的神奇,但是百度确针对这一系列的算法作出了公告与K站降权的举动,不得不使我仔细剖析百度算法的原理,以下几个算法仅为我个人猜测。

百度绿萝算法:

我始终不相信百度绿萝算法居然可以算下来你的链接是否订购的,但是实际百度却做到了,其中主要原理还是按照一个网站对另一个网站的链接判定,是否有反向链接、链接个数来进行判定。

百度石榴算法:

石榴算法主要严打的对象为低质量页面,其中百度蜘蛛主要是依据网站html代码来抓取的,并且搜索引擎依据文章的标签(收录排版)、重复读来进行判定网站的质量。

百度星火计划:

星火计划的原计划是为了严打抄袭者,其星火计划的原理十分简单了,也就是判定重复读来决定网站是否剽窃,同时百度蜘蛛也肯定了自己的抓取程序,目前正在往每一个网站时刻爬取靠拢。

百度惊雷算法:

百度惊雷算法严厉严打通过刷点击,提升网站搜索排序的作弊行为;以此保证搜索用户体验,促进搜索内容生态良性发展。

百度冰桶算法:

百度移动搜索将针对低质站点及页面进行一系列调整,我们称之为冰桶算法。影响范围:强行弹窗app下载、用户登入、大面积广告等影响用户正常浏览体验的页面,尤其以必须下载app能够正常使用的站点为代表。从整个联通互联网生态环境看,越来越多的网站进行这种强推,这早已严重影响了正常用户的浏览体验。

百度优采云算法:

优采云算法,是百度搜索引擎针对新闻源站点售卖软文、目录等严重违背新闻源规则,并影响用户搜索体验行为,于2016年11月即将启用的一种搜索引擎算法规则,其目的是严厉严打新闻源售卖软文、目录行为,还用户一片搜索优采云。

百度天网算法:

天网算法主要是针对网页搜索发觉部份站点存在窃取用户隐私的行为进行严打。主要表现为网页嵌恶意代码(多为JS代码),用于窃取网民的QQ号、手机号。

百度飓风算法:

百度搜索于近期推出飓风算法,旨在严厉严打以恶劣采集为内容主要来源的网站,同时百度搜索将从索引库中彻底消除恶劣采集链接,给优质原创内容提供更多展示机会,促进搜索生态良性发展。

飓风算法会例行产出惩罚数据,同时会按照情况随时调整迭代,体现了百度搜索对恶劣采集的零容忍。优质原创站点如发觉站点索引量急剧降低且流量急剧下降现象,可在反馈中心进行反馈。

百度清风算法:

百度搜索将于9月底推出清风算法,旨在惩处网站通过网页标题作弊,欺骗用户并获得点击的行为;从而保证搜索用户体验,促进搜索生态良性发展。

百度闪电算法:

关于百度上线 “闪电算法”的公告2017年10月初,“闪电算法”上线,移动搜索页面首屏加载时间将影响搜索排名。移动网页首屏在2秒之内完成打开的,在联通搜索下将获得提高页面评价优待,获得流量倾斜;同时,在联通搜索页面首屏加载特别慢(3秒及以上)的网页将会被打压。

【算法颁布时间:2018年4月19日】

【清风算法2.0】—严厉严打误导下载,主要严打以下两种类型:

1.实际下载的资源与需求不符;

2.提供了下载链接、实际站点无下载资源。

清风算法2.0,对于误导用户下载的问题进行永久封禁。

【算法颁布时间:2018年5月17日】

【烽火算法2.0】—严厉严打恶意绑架惩处,“窃取用户数据”和“恶意绑架”的行为。

主要针对:

1.未经用户准许恶意盗用用户手机号码等隐私数据的行为;

2.恶意绑架百度流量的行为(返回上一级页面被绑架到虚假的百度搜索结果页中或则网站站内)。

【算法颁布时间:2018年5月23日】

【惊雷算法2.0】—对“恶意制造作弊超链”和“恶意刷点击”的作弊行为进行算法升级,相对于炸雷算法1.0。 这次升级主要针对“恶意制造作弊超链”和“恶意刷点击”的作弊行为进行了算法升级。惊雷算法2.0将对作弊的网站限制搜索诠释、清洗作弊链接、清洗点击,并会将站点作弊行为记入站点历史,严重者将永久封禁。

【算法颁布时间:2018年5月31日】

【极光算法】—倡导注重落地页时间规范

落地页时间因子是百度搜索判定网站收录、展示、排序结果的重要参考根据。

为了使用户获得更满意的搜索浏览体验,搜索引擎将给与符合落地页时间因子要求且时效性较高的网页更多的收录、展现机会,同时降低不符合规定的网站的诠释机会。

【算法颁布时间:2018年6月7日】

【季风算法】—重点严打违背熊掌号专注度要求的熊掌号。

百度提倡熊掌号领域专注度,对于违背熊掌号领域专注度要求的熊掌号将重点严打。

如有新算法颁布,会持续更新此报告,敬请关注!

总结:

不管算法规则如何更新,百度不变的是为了用户体验,所以我们在优化的时侯优先考虑用户体验,以用户为中心构建用户需求。

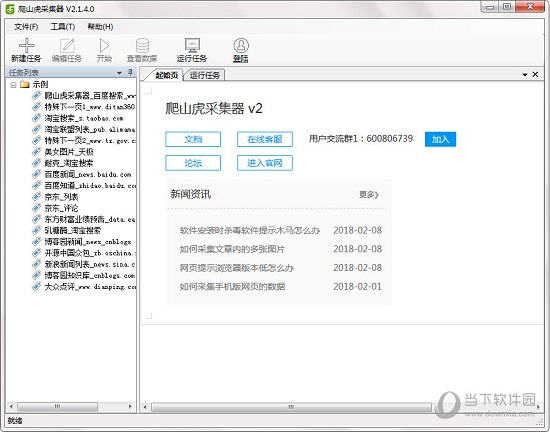

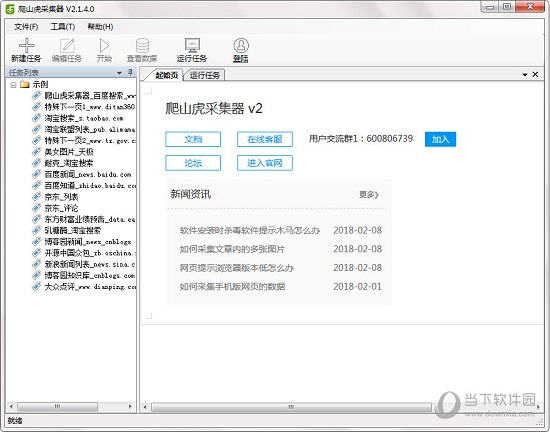

优采云采集器 V2.4.9.0 官方版

采集交流 • 优采云 发表了文章 • 0 个评论 • 303 次浏览 • 2020-08-26 10:09

优采云采集器是一款新一代智能化的网页采集工具,智能剖析、可视化界面,一键采集无需编程,支持手动生成采集脚本,可以采集互联网99%的网站。软件简单易学,通过智能算法+可视化界面,随心所欲,抓取自己想到的数据。只要轻松点击滑鼠,就能采集网页上的数据。

【软件特色】

一键提取数据

简单易学,通过可视化界面,鼠标点击即可抓取数据

快速高效

内置一套高速浏览器内核,加上HTTP引擎模式,实现快速采集数据

适用各类网站

能够采集互联网99%的网站,包括单页应用Ajax加载等等动态类型网站

【功能介绍】

向导模式

简单易用,轻松通过滑鼠点击手动生成

脚本定时运行

可依照计划定时运行,无需人工

独创高速内核

自研的浏览器内核,速度飞快,远超对手

智能辨识

对于网页中的列表、表单结构(多选框下拉列表等)能够智能辨识

广告屏蔽

定制的广告屏蔽模块,兼容AdblockPlus句型,可添加自定义规则

多种数据导入

支持Txt 、Excel、MySQL、SQLServer、SQlite、Access、网站等

【使用流程】

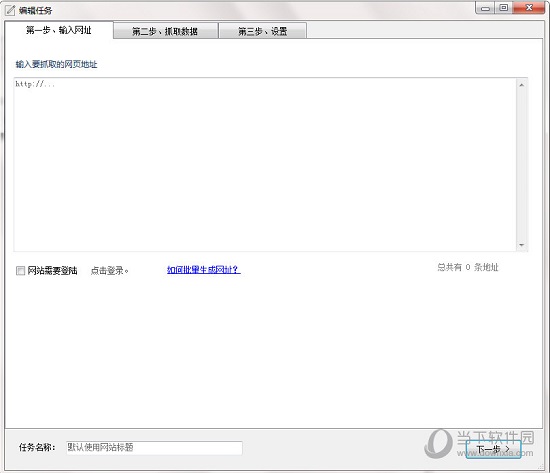

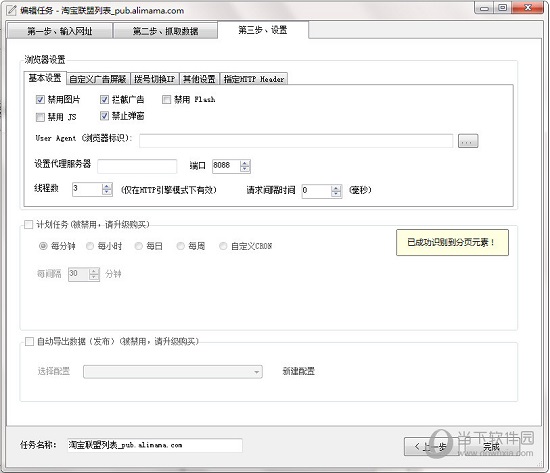

输入采集网址

打开软件,新建任务,输入须要采集的网站地址。

智能剖析,全程自动化提取数据

进入到第二步后,优采云采集器全手动智能剖析网页,并且从中提取出列表数据。

导出数据到表格、数据库、网站等

运行任务,将采集到的数据导入为Csv、Excel以及各类数据库,支持api导入。

【常见问题】

问:如何过滤列表中的前N个数据?

1、有时我们须要对采集到的列表进行过滤,比如过滤掉第一组数据(在采集表格时,过滤掉表格列名)

2、点击列表模式菜单中的,设置列表xpath

问:如何抓包获取Cookie,并且自动设置?

1、首先,使用谷歌浏览器打开要采集的网站,并且登入。

2、然后按下 F12,会出现开发者工具,选择 Network

3、然后按下F5,刷新下页面, 选择其中一个恳求。

4、复制完成后,在优采云采集器中,编辑任务,进入第三步,指定HTTP Header。

【更新日志】

优化网页表格数据的辨识,可根据表格列名手动命名数组

优化时间提取

修复当有自定义数组,没有匹配到不保存数据的问题

添加时间戳变量

计划任务,每间隔分钟降低开始秒 查看全部

优采云采集器 V2.4.9.0 官方版

优采云采集器是一款新一代智能化的网页采集工具,智能剖析、可视化界面,一键采集无需编程,支持手动生成采集脚本,可以采集互联网99%的网站。软件简单易学,通过智能算法+可视化界面,随心所欲,抓取自己想到的数据。只要轻松点击滑鼠,就能采集网页上的数据。

【软件特色】

一键提取数据

简单易学,通过可视化界面,鼠标点击即可抓取数据

快速高效

内置一套高速浏览器内核,加上HTTP引擎模式,实现快速采集数据

适用各类网站

能够采集互联网99%的网站,包括单页应用Ajax加载等等动态类型网站

【功能介绍】

向导模式

简单易用,轻松通过滑鼠点击手动生成

脚本定时运行

可依照计划定时运行,无需人工

独创高速内核

自研的浏览器内核,速度飞快,远超对手

智能辨识

对于网页中的列表、表单结构(多选框下拉列表等)能够智能辨识

广告屏蔽

定制的广告屏蔽模块,兼容AdblockPlus句型,可添加自定义规则

多种数据导入

支持Txt 、Excel、MySQL、SQLServer、SQlite、Access、网站等

【使用流程】

输入采集网址

打开软件,新建任务,输入须要采集的网站地址。

智能剖析,全程自动化提取数据

进入到第二步后,优采云采集器全手动智能剖析网页,并且从中提取出列表数据。

导出数据到表格、数据库、网站等

运行任务,将采集到的数据导入为Csv、Excel以及各类数据库,支持api导入。

【常见问题】

问:如何过滤列表中的前N个数据?

1、有时我们须要对采集到的列表进行过滤,比如过滤掉第一组数据(在采集表格时,过滤掉表格列名)

2、点击列表模式菜单中的,设置列表xpath

问:如何抓包获取Cookie,并且自动设置?

1、首先,使用谷歌浏览器打开要采集的网站,并且登入。

2、然后按下 F12,会出现开发者工具,选择 Network

3、然后按下F5,刷新下页面, 选择其中一个恳求。

4、复制完成后,在优采云采集器中,编辑任务,进入第三步,指定HTTP Header。

【更新日志】

优化网页表格数据的辨识,可根据表格列名手动命名数组

优化时间提取

修复当有自定义数组,没有匹配到不保存数据的问题

添加时间戳变量

计划任务,每间隔分钟降低开始秒

骨灰级乐高粉述说:我是怎样用算法给两吨积木手动分类的

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2020-08-26 08:22

唐旭 编译自Jacques Mattheij博客

量子位 出品 | 公众号 QbitAI

本文的作者Jacques Mattheij自小就是一名乐高粉。在接触乐高的过程中,他发觉了如此一种现象:不同种类的乐高售价是不同的。比如精装乐高的售价大约是每公斤40欧元,散装的乐高只须要10欧元;而一些限量、稀有版本以及乐高机械组的售价能达到每公斤100欧元。

为此甚至有人专门去买这些散装和精装新款的乐高,然后把它们进行重新分类以获取更高的价值。

然而,手动给这些千奇百怪的乐高分类看上去并不是个好主意。于是Mattheij某日突发奇想,决定尝试用机器干这件事。他在各个拍卖网站上拍下了能装满一整车库的乐高(运回去途中还丢了辆货车)来做这个实验。

这是Mattheij在个人网站上发布的第二篇贴子,讲的是他为给这堆乐高分类而在软件上尝试过的方式;在第一篇贴子里,他介绍了硬件方面的打算和面临的困难。

我们先跳过买几车乐高、安装摄像头、传送带等等过程,来瞧瞧他是如何写这个分类程序的。如果你对硬件部份更有兴趣,请到这儿围观:

以下内容编译自Mattheij的第二篇贴子:

概述

全部的软件都是用Python写下来的。我本人并不是Python专家,不过好在我也不至于花一辈子能够把它弄会。Anaconda是一种非常好用的Python分发工具。原本,要解决各类关联性和版本问题,给Python设置一个虚拟环境这种事简直就是个恶梦。而对我来讲,Anaconda能帮上很大的忙。

关于乐高分类软件,有个主要部份。比如说,一个通过摄像头实现的图象采集系统:

扫描仪/“图像缝纫机”

采集器完成工作后,会将图象发送到“图像缝纫机”(把两张图接在一起)上,后者的主要任务是两件事:一是判断自从上一张图象然后带着某块乐高的传送带联通了多少( 看视频里的波浪线),二是更新一张新扫描进来的显存图象。在两块乐高中间隔开的部份“缝纫机”会剪一下,然后把下一张扫进来的乐高图象接上。

上述这种都是用OpenCV写下来的。

扫描器和“图像缝纫机”完成了自己的工作后,成果看起来是这样的:

分类

这是这件事真正有趣的部份。这块我弄过好多次,现在早已烦得不行了。

OpenCV基元

我第一次选择的方式是用OpenCV基元,特别是其中的轮廓匹配和圆监测。只要处理乐高的种类没那么多,用这些方法就能够保证一个相对不错的辨识准确率。结合一部分简单的元数据(比一块乐高的长、宽、高),它能够区分出所有基本型乐高积木块之间的区别,不过也不能再多了。

贝叶斯

换种方法,我们试试贝叶斯。贝叶斯分类器相当好理解:你先设计一大堆特点,然后根据这种特点建立检测器,之后再创建一个测试集以保证你的检测器运行得如同她们告诉你的那样好,都完成以后,你就尽己所能增强系统对这些特点的辨识能力。你要把一个尽可能大的测试图象集扔到这个系统里去跑,以确定你所设定特点的优先级,进而确定每位特点所占的权重——如果某一特点出现才会被测量为“正确”,特征没有出现才会被测量为“错误”。

我用这些技巧构建了一个基于如下特点的分类器:

可能还有其他的特点……这些我弄了好一阵子。做一个“螺柱检测器”看上去微不足道,但毕竟事情也没那么简单。你须要记着螺柱可能坐落任何方向,还有一些可能被辨识成螺柱但显然并非螺柱的细小部件,积木可能会是颠倒放置,还可能是背对摄像头的。类似的问题几乎在每种特点上都要出现一遍,最后你要耗费大量的精力去调整,才能使系统达到一个令你满意的状态。不过一旦你把里面那些都搞定,你还会收获一个就能测量好多不同种类积木、也能保证不错准确率的分类器了。

即便这般,这套系统距尽善尽美也还差得很远:它很慢了。每一次你往里添加进全新类别的积木,你就要为搞明白一块积木究竟属于那个类别而做更多的工作。电脑在集合元素上耗费了大量的时间产生了一个不断膨胀的积木形状库,最佳匹配结果就从库里得出。系统的准确率令人印象深刻,但最后由于速率很慢(跟不上传送机器的速率),我还是舍弃了这些方案。

剔除法

剔除系统使用了和上一种方式相同的分类条件。按有效性递减规则进行分类可以快速地将不合规则的对象剔除出去,剩余部份就可以被高效处理。这是第一次,软件能跟上全速运行的机器。

不过这些方案同样存在几个问题:一旦某件积木被剔除掉了,它就再也回不来了——但这个剔除可能是错误的。事实是这些“二进制”的方法确实限制了系统的准确率,你须要一个十分庞大的数据集能够使这个系统跑起来,而这将在很大程度上减少整体效能。

这个系统常常到最后把所有东西都剔除掉了——这样它就毫无益处了。因此,为修正准确率而付出的成本太可能就把它在速率上的优势抵消了。

树形分类

这是个因吹斯汀的看法。我照着一个叫“猜植物”游戏里的台词简单做了棵大树,每次往里边加入新的东西时这棵树才会找出特点中不同的部份并在里面分出一个叉来放入新的积木。与剔除法相比,这种方式有两种特别重要的优势:一是一块积木能用树上的多个点表示,这回帮助提高准确率;二是与之前的方式相比,这个系统的速率简直就和闪电一样快。

但这些方式同样存在显著的弊病:起初的时侯你须要自动去创造所有这种特点,而即使你能找到足够清晰的特点,只靠基本的OpenCV写一个特征检测器,这个过程也实在是很过繁琐厌倦了……很快,这个事都会显得更不好办,特别是Python属于那个相当慢的语言,如果你的问题不能用NumPy或OpenCV库调拿来表示,在速率上就要要不得了。

机器学习

终于讲到这了!被前面这些乱七八糟的方式摧残了差不多六个月后,我受够了。我意识到,要写一个能将所有乐高积木种类都完整包括在内的、能真正干起活来的分类器根本就是不可能的。当然,这使我失望了好一阵子。

我决定咬咬牙拼了。我把眼神投向了机器学习,并且以一种更为严肃认真的方法来对待它:接下来的数周里我都在啃论文,学习各类与神经网路相关的有趣事情。

上世纪80年代,我以前与神经网路有过短暂接触,而如今我发觉,这一领域与当时相比,已经发生了很大变化。

经过不少研究,我最终决定选择微软脑部团队开发的TensorFlow。但要真正学会用这个也须要一个过程,一开始我就在里面卡住了好一阵子,不知道怎样处理最好。

大概两个月前,一为叫greenpizza13的Hacker News用户给我推荐了Keras,让我就能直接使用TensorFlow而不至于再去兜个大圈子(Anaconda能帮上很大的忙),而这也直接把我领向了Jeremy Howard和Rachel Thomas棒极了的机器学习入门课(课程链接:)。

结果,在几个小时内(是的你没看错),我得到的结果就实现了对过去几个月里实践过的所有方案的赶超;而在几天之内我就让分类系统实现了真正的实时工作,而不是智能简单地分个几类。再多吹一点:不管是在训练还是推理中,大概2000行特点检查代码以及另外2000行测试和胶带(glue)代码可以被多于200行的Keras代码替代了。

与其他自动对特点进行编码的方法相比,机器学习在速率与编码简易度上的优势真是简直了。虽然它不如树形机制这么快,准确率却比它不知道要高到那里去了;与此同时,你还不用为这些千奇百怪的积木门类手写代码了,系统能手动搞定。

接下来的麻烦事在于,我要搞出一个足够大的训练数据集,来保证系统能进行1000种以上的分类。起初这看上去就是个不可能完成的任务,我不知道怎么样就能搞到足够的图象而且在可接受的时间内自动对它进行标明,即便按最豁达的情况估算,要搞出一个足够大的数据集,从而使这套系统按理想状态跑起来也要花上我6个月的时间。

最后我想通了:这事不重要。大部分时间里都可以使机器自己对自己的图象进行标明,而我所要做的就是修正它的错误。随着系统的运行,错误也显得越来越少。这种方法十分迅速地扩展了训练图像集。第一天,我自动标明了500块积木;第二天,机器把这个数字提升到了2000,当然,其中有大约一半都标错了——这2500件积木就成了接下来一天这轮训练的基础数据,而最后机器标明了超过4000块乐高,其中90%都是正确的!我只须要修正400块错误的就行了。在这两周的最后,我早已有了一个全部正确标明的20000张图象的数据集。

这还远远不够,其中的一些类别十分不具有代表性,因此我需要增强这种类别中的图象数目,我恐怕应当把这部份拉下来单独在机器上处理一遍——不需要再进行任何修正,它们将被同样地标明。

自上周发布第一篇贴子后我收获了好多帮助,这里我想非常谢谢两个人。一是Jeremy Howard,他帮我补上了知识的空缺,没有他的帮助,我都开不了头;第二位是Francois Chollet,Keras的作者,他将自己自定义版本的Xception模型提供给了我,大大加速了训练的进程。

现在训练在速率上深陷了困局,即使我的Nvidia GPU早已够快的了,我还是嫌它跑得慢。要生成一个新的网路须要耗费几天时间,在一台有4个GPU的机器上,这速率真是不行……我是个没哪些耐心的人,不过生使这个事给练下来了。

在某一时刻这种软件和数据就会被开源,但在此之前,我还有太长一段路要走。

什么时候软件真正具备给这一大堆散装乐高分类的能力了,翻身的日子就该到了。等我把这堆山一样的乐高拾掇完,我就把它们廉价处理出去。

最后,这是一张呈现我先前设想的概念图,全是用乐高拼下来的:

招聘

量子位正在招募编辑记者、运营、产品等岗位,工作地点在上海中关村。相关细节,请在公众号对话界面,回复:“招聘”。

One More Thing…

今天AI界还有什么事值得关注?在量子位(QbitAI)公众号对话界面回复“今天”,看我们全网搜罗的AI行业和研究动态。笔芯~ 查看全部

骨灰级乐高粉述说:我是怎样用算法给两吨积木手动分类的

唐旭 编译自Jacques Mattheij博客

量子位 出品 | 公众号 QbitAI

本文的作者Jacques Mattheij自小就是一名乐高粉。在接触乐高的过程中,他发觉了如此一种现象:不同种类的乐高售价是不同的。比如精装乐高的售价大约是每公斤40欧元,散装的乐高只须要10欧元;而一些限量、稀有版本以及乐高机械组的售价能达到每公斤100欧元。

为此甚至有人专门去买这些散装和精装新款的乐高,然后把它们进行重新分类以获取更高的价值。

然而,手动给这些千奇百怪的乐高分类看上去并不是个好主意。于是Mattheij某日突发奇想,决定尝试用机器干这件事。他在各个拍卖网站上拍下了能装满一整车库的乐高(运回去途中还丢了辆货车)来做这个实验。

这是Mattheij在个人网站上发布的第二篇贴子,讲的是他为给这堆乐高分类而在软件上尝试过的方式;在第一篇贴子里,他介绍了硬件方面的打算和面临的困难。

我们先跳过买几车乐高、安装摄像头、传送带等等过程,来瞧瞧他是如何写这个分类程序的。如果你对硬件部份更有兴趣,请到这儿围观:

以下内容编译自Mattheij的第二篇贴子:

概述

全部的软件都是用Python写下来的。我本人并不是Python专家,不过好在我也不至于花一辈子能够把它弄会。Anaconda是一种非常好用的Python分发工具。原本,要解决各类关联性和版本问题,给Python设置一个虚拟环境这种事简直就是个恶梦。而对我来讲,Anaconda能帮上很大的忙。

关于乐高分类软件,有个主要部份。比如说,一个通过摄像头实现的图象采集系统:

扫描仪/“图像缝纫机”

采集器完成工作后,会将图象发送到“图像缝纫机”(把两张图接在一起)上,后者的主要任务是两件事:一是判断自从上一张图象然后带着某块乐高的传送带联通了多少( 看视频里的波浪线),二是更新一张新扫描进来的显存图象。在两块乐高中间隔开的部份“缝纫机”会剪一下,然后把下一张扫进来的乐高图象接上。

上述这种都是用OpenCV写下来的。

扫描器和“图像缝纫机”完成了自己的工作后,成果看起来是这样的:

分类

这是这件事真正有趣的部份。这块我弄过好多次,现在早已烦得不行了。

OpenCV基元

我第一次选择的方式是用OpenCV基元,特别是其中的轮廓匹配和圆监测。只要处理乐高的种类没那么多,用这些方法就能够保证一个相对不错的辨识准确率。结合一部分简单的元数据(比一块乐高的长、宽、高),它能够区分出所有基本型乐高积木块之间的区别,不过也不能再多了。

贝叶斯

换种方法,我们试试贝叶斯。贝叶斯分类器相当好理解:你先设计一大堆特点,然后根据这种特点建立检测器,之后再创建一个测试集以保证你的检测器运行得如同她们告诉你的那样好,都完成以后,你就尽己所能增强系统对这些特点的辨识能力。你要把一个尽可能大的测试图象集扔到这个系统里去跑,以确定你所设定特点的优先级,进而确定每位特点所占的权重——如果某一特点出现才会被测量为“正确”,特征没有出现才会被测量为“错误”。

我用这些技巧构建了一个基于如下特点的分类器:

可能还有其他的特点……这些我弄了好一阵子。做一个“螺柱检测器”看上去微不足道,但毕竟事情也没那么简单。你须要记着螺柱可能坐落任何方向,还有一些可能被辨识成螺柱但显然并非螺柱的细小部件,积木可能会是颠倒放置,还可能是背对摄像头的。类似的问题几乎在每种特点上都要出现一遍,最后你要耗费大量的精力去调整,才能使系统达到一个令你满意的状态。不过一旦你把里面那些都搞定,你还会收获一个就能测量好多不同种类积木、也能保证不错准确率的分类器了。

即便这般,这套系统距尽善尽美也还差得很远:它很慢了。每一次你往里添加进全新类别的积木,你就要为搞明白一块积木究竟属于那个类别而做更多的工作。电脑在集合元素上耗费了大量的时间产生了一个不断膨胀的积木形状库,最佳匹配结果就从库里得出。系统的准确率令人印象深刻,但最后由于速率很慢(跟不上传送机器的速率),我还是舍弃了这些方案。

剔除法

剔除系统使用了和上一种方式相同的分类条件。按有效性递减规则进行分类可以快速地将不合规则的对象剔除出去,剩余部份就可以被高效处理。这是第一次,软件能跟上全速运行的机器。

不过这些方案同样存在几个问题:一旦某件积木被剔除掉了,它就再也回不来了——但这个剔除可能是错误的。事实是这些“二进制”的方法确实限制了系统的准确率,你须要一个十分庞大的数据集能够使这个系统跑起来,而这将在很大程度上减少整体效能。

这个系统常常到最后把所有东西都剔除掉了——这样它就毫无益处了。因此,为修正准确率而付出的成本太可能就把它在速率上的优势抵消了。

树形分类

这是个因吹斯汀的看法。我照着一个叫“猜植物”游戏里的台词简单做了棵大树,每次往里边加入新的东西时这棵树才会找出特点中不同的部份并在里面分出一个叉来放入新的积木。与剔除法相比,这种方式有两种特别重要的优势:一是一块积木能用树上的多个点表示,这回帮助提高准确率;二是与之前的方式相比,这个系统的速率简直就和闪电一样快。

但这些方式同样存在显著的弊病:起初的时侯你须要自动去创造所有这种特点,而即使你能找到足够清晰的特点,只靠基本的OpenCV写一个特征检测器,这个过程也实在是很过繁琐厌倦了……很快,这个事都会显得更不好办,特别是Python属于那个相当慢的语言,如果你的问题不能用NumPy或OpenCV库调拿来表示,在速率上就要要不得了。

机器学习

终于讲到这了!被前面这些乱七八糟的方式摧残了差不多六个月后,我受够了。我意识到,要写一个能将所有乐高积木种类都完整包括在内的、能真正干起活来的分类器根本就是不可能的。当然,这使我失望了好一阵子。

我决定咬咬牙拼了。我把眼神投向了机器学习,并且以一种更为严肃认真的方法来对待它:接下来的数周里我都在啃论文,学习各类与神经网路相关的有趣事情。

上世纪80年代,我以前与神经网路有过短暂接触,而如今我发觉,这一领域与当时相比,已经发生了很大变化。

经过不少研究,我最终决定选择微软脑部团队开发的TensorFlow。但要真正学会用这个也须要一个过程,一开始我就在里面卡住了好一阵子,不知道怎样处理最好。

大概两个月前,一为叫greenpizza13的Hacker News用户给我推荐了Keras,让我就能直接使用TensorFlow而不至于再去兜个大圈子(Anaconda能帮上很大的忙),而这也直接把我领向了Jeremy Howard和Rachel Thomas棒极了的机器学习入门课(课程链接:)。

结果,在几个小时内(是的你没看错),我得到的结果就实现了对过去几个月里实践过的所有方案的赶超;而在几天之内我就让分类系统实现了真正的实时工作,而不是智能简单地分个几类。再多吹一点:不管是在训练还是推理中,大概2000行特点检查代码以及另外2000行测试和胶带(glue)代码可以被多于200行的Keras代码替代了。

与其他自动对特点进行编码的方法相比,机器学习在速率与编码简易度上的优势真是简直了。虽然它不如树形机制这么快,准确率却比它不知道要高到那里去了;与此同时,你还不用为这些千奇百怪的积木门类手写代码了,系统能手动搞定。

接下来的麻烦事在于,我要搞出一个足够大的训练数据集,来保证系统能进行1000种以上的分类。起初这看上去就是个不可能完成的任务,我不知道怎么样就能搞到足够的图象而且在可接受的时间内自动对它进行标明,即便按最豁达的情况估算,要搞出一个足够大的数据集,从而使这套系统按理想状态跑起来也要花上我6个月的时间。

最后我想通了:这事不重要。大部分时间里都可以使机器自己对自己的图象进行标明,而我所要做的就是修正它的错误。随着系统的运行,错误也显得越来越少。这种方法十分迅速地扩展了训练图像集。第一天,我自动标明了500块积木;第二天,机器把这个数字提升到了2000,当然,其中有大约一半都标错了——这2500件积木就成了接下来一天这轮训练的基础数据,而最后机器标明了超过4000块乐高,其中90%都是正确的!我只须要修正400块错误的就行了。在这两周的最后,我早已有了一个全部正确标明的20000张图象的数据集。

这还远远不够,其中的一些类别十分不具有代表性,因此我需要增强这种类别中的图象数目,我恐怕应当把这部份拉下来单独在机器上处理一遍——不需要再进行任何修正,它们将被同样地标明。

自上周发布第一篇贴子后我收获了好多帮助,这里我想非常谢谢两个人。一是Jeremy Howard,他帮我补上了知识的空缺,没有他的帮助,我都开不了头;第二位是Francois Chollet,Keras的作者,他将自己自定义版本的Xception模型提供给了我,大大加速了训练的进程。

现在训练在速率上深陷了困局,即使我的Nvidia GPU早已够快的了,我还是嫌它跑得慢。要生成一个新的网路须要耗费几天时间,在一台有4个GPU的机器上,这速率真是不行……我是个没哪些耐心的人,不过生使这个事给练下来了。

在某一时刻这种软件和数据就会被开源,但在此之前,我还有太长一段路要走。

什么时候软件真正具备给这一大堆散装乐高分类的能力了,翻身的日子就该到了。等我把这堆山一样的乐高拾掇完,我就把它们廉价处理出去。

最后,这是一张呈现我先前设想的概念图,全是用乐高拼下来的:

招聘

量子位正在招募编辑记者、运营、产品等岗位,工作地点在上海中关村。相关细节,请在公众号对话界面,回复:“招聘”。

One More Thing…

今天AI界还有什么事值得关注?在量子位(QbitAI)公众号对话界面回复“今天”,看我们全网搜罗的AI行业和研究动态。笔芯~

文本信息抽取算法研究.doc

采集交流 • 优采云 发表了文章 • 0 个评论 • 193 次浏览 • 2020-08-26 00:00

文档介绍:

文本信息抽取算法研究

(黑龙江工商学院四川成都 150025)

中国论文网/8/view-12937846.htm

随着商品在线评论数目的急剧降低,消费者要想找出商品评论中的有用信息须要消耗大量精力.因此对这种飘散在Html网页中无结构的信息进行提取、分析,不仅还能帮助消费者从海量的文本中快速获得有效的信息,节省人力成本,也可以帮助企业改进产品、提高质量,从而为电子商务产品推荐提供一种新的营销模式.为有效的抽取互联网上的信息,网络文本信息非结构化数据抽取技术、网络文本信息采集技术和细细度数据挖掘技术应用而生.信息抽取技术是通过对网页进行处理,从半结构化或则非结构化的Web页面中抽取出用户感兴趣的信息和内容,并将其转化成清晰的结构方式.

信息采集技术是指通过剖析网页Html代码,获取网页内的超链接信息,并使用广度优先遍历算法、深度优先遍历算法、增量储存算法等实现手动连续的剖析链接、抓取文件、处理和保存数据的过程.细细度挖掘技术深入到产品特点层面,能够提取到评价信息中涉及的评价对象、评价词以及对应的评价倾向等意见要素,从而为一些实际应用提供必要的细节信息.而目前依据抽取技术和根据理论的不同,主要有RAPIERE 、WHISKt 和SRV基于自然语言的信息抽取,STAI KER,SOFTMEAI Y和WINE基于包装归纳的信息抽取,WebQLE基于Web查询的信息抽取,基于文档结构模型和网页模板的DOM 信息抽取。

面对海量数据,抽取技术的性能是一个非常重要的评价指标,而通过网页结构剖析并使用语言和格式规则进行标签筛选的技术却甚少.HtmlParser是不依赖于库文件的轻量级解析器,通过语言与格式规则进行标签筛选,过滤目标数据,在保持系统抽取效率的基础上保证抽取算法的准确性.本文首先介绍了URI 采集以及文本抽取的过程,其次给出了URL采集和文本抽取算法的关键步骤,再次通过举例实现了URL采集和文本抽取算法,表明了基于语言和格式规则的HtmlParser标签解析技术的性能和优势.采用HtmlParser解析网页,得到URL采集库,对库中URL所指向的页面进行标签解析因而实现文本提取的关键部份.

1 URL信息采集算法

信息采集过程的算法设计思想是:首先由一个初始URL对队列进行初始化,然后从队列中取出一个元素,获取此元素所指向的Web页面,对页面进行网页源代码解析,得到目标标签中的URL,将其入队,然后重复前面的过程,不断执行入队一出队一解析一获得URL的循环操作,直到按照采集策略停止算法,具体过程

算法1:URL采集算法

输入:初始URL

输出:URL采集库

1)首先判定参数URL是否为Null;

2)如果为Null,程序退出;否则,根据URL得

到Html页面;

3)利用页面解析器HtmlParser解析网页;

4)分析Html源代码中具体URL信息所在节

点标签;

5)利用标签的href属性,过滤得到下一

页的网页URL地址;

6)将步骤5中的URL地址值传到步骤1,重复

1)~6)的步骤;

7)最后遍历得到所有的目标URL地址,建成

URL采集库.

2 网页文本内容抽取算法 查看全部

文本信息抽取算法研究.doc

文档介绍:

文本信息抽取算法研究

(黑龙江工商学院四川成都 150025)

中国论文网/8/view-12937846.htm

随着商品在线评论数目的急剧降低,消费者要想找出商品评论中的有用信息须要消耗大量精力.因此对这种飘散在Html网页中无结构的信息进行提取、分析,不仅还能帮助消费者从海量的文本中快速获得有效的信息,节省人力成本,也可以帮助企业改进产品、提高质量,从而为电子商务产品推荐提供一种新的营销模式.为有效的抽取互联网上的信息,网络文本信息非结构化数据抽取技术、网络文本信息采集技术和细细度数据挖掘技术应用而生.信息抽取技术是通过对网页进行处理,从半结构化或则非结构化的Web页面中抽取出用户感兴趣的信息和内容,并将其转化成清晰的结构方式.

信息采集技术是指通过剖析网页Html代码,获取网页内的超链接信息,并使用广度优先遍历算法、深度优先遍历算法、增量储存算法等实现手动连续的剖析链接、抓取文件、处理和保存数据的过程.细细度挖掘技术深入到产品特点层面,能够提取到评价信息中涉及的评价对象、评价词以及对应的评价倾向等意见要素,从而为一些实际应用提供必要的细节信息.而目前依据抽取技术和根据理论的不同,主要有RAPIERE 、WHISKt 和SRV基于自然语言的信息抽取,STAI KER,SOFTMEAI Y和WINE基于包装归纳的信息抽取,WebQLE基于Web查询的信息抽取,基于文档结构模型和网页模板的DOM 信息抽取。

面对海量数据,抽取技术的性能是一个非常重要的评价指标,而通过网页结构剖析并使用语言和格式规则进行标签筛选的技术却甚少.HtmlParser是不依赖于库文件的轻量级解析器,通过语言与格式规则进行标签筛选,过滤目标数据,在保持系统抽取效率的基础上保证抽取算法的准确性.本文首先介绍了URI 采集以及文本抽取的过程,其次给出了URL采集和文本抽取算法的关键步骤,再次通过举例实现了URL采集和文本抽取算法,表明了基于语言和格式规则的HtmlParser标签解析技术的性能和优势.采用HtmlParser解析网页,得到URL采集库,对库中URL所指向的页面进行标签解析因而实现文本提取的关键部份.

1 URL信息采集算法

信息采集过程的算法设计思想是:首先由一个初始URL对队列进行初始化,然后从队列中取出一个元素,获取此元素所指向的Web页面,对页面进行网页源代码解析,得到目标标签中的URL,将其入队,然后重复前面的过程,不断执行入队一出队一解析一获得URL的循环操作,直到按照采集策略停止算法,具体过程

算法1:URL采集算法

输入:初始URL

输出:URL采集库

1)首先判定参数URL是否为Null;

2)如果为Null,程序退出;否则,根据URL得

到Html页面;

3)利用页面解析器HtmlParser解析网页;

4)分析Html源代码中具体URL信息所在节

点标签;

5)利用标签的href属性,过滤得到下一

页的网页URL地址;

6)将步骤5中的URL地址值传到步骤1,重复

1)~6)的步骤;

7)最后遍历得到所有的目标URL地址,建成

URL采集库.

2 网页文本内容抽取算法

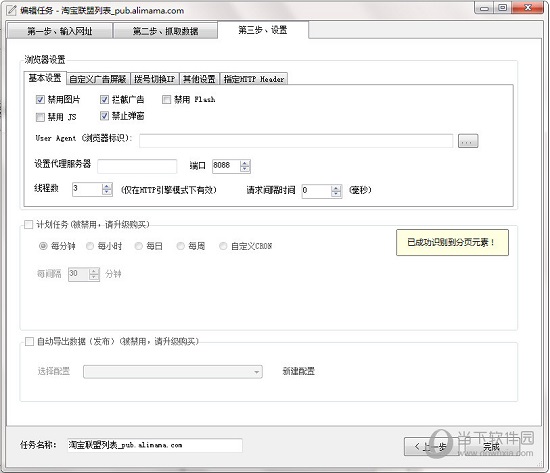

互联网上笑话抽取及排重---优采云采集器的使用和MD5算法的应用

采集交流 • 优采云 发表了文章 • 0 个评论 • 287 次浏览 • 2020-08-25 23:41

图2 编辑任务

下面学习过程介绍均以开心驿站为例表述

第一步:采集网址规则

首先要先添加起始网址 接下来的笑话网址采集就分为两种形式。

第一种就是在“添加开始采集地址”窗体中设置“批量/多页”项,设置“等差数列”方式,即采集的笑话从第一页到最后一页,这些页数是成公差为1的等差数列,如图3所示

图3 批量/多页设置

将“开心驿站”上面各种笑话设置完全,效果图如图3所示

图4 起始网址效果图

当然,如果仅此设置的话,我们一页只能采到一条笑话,实际上,“开心驿站”上面的一页可以显示16条笑话,这样我们还要设置一下“多级网址采集规则”。可以自动剖析页面html格式,然后填写规则,这里采用最简单的可视化Xpath方法获取地址。如图5所示

图5 Xpath方法获取地址

我们可以看出多级网址获取方法为get如图6所示

图6 多级网址设置效果图

第二种就是不在设置“批量/多页”,而是直接设置“多级网址获取”,首先获得“开心驿站”上面各个分类的默认打开地址。

例如“校园笑话”,这些网址的获取,我们同样采用的是最简单的可视化地址Xpath方法获得。Xpath获得的网址上面有可能不是我们想要的网址,比如list10-1和list13-1分别为图片和视频,所以我们可以进行“结果网址过滤”如图7所示

图7 结果网址过滤设置

接下来就是“列表分页获取”设置,这个就是对每位分类的默认页进行下一页的采集,根据html上面的格式,我们如图8所示设置

图8 列表分页获取设置

至于每一页要采集到16条笑话的网址,这个就和第一种方法是一样的。就此略过。

第二步 采集内容规则

首先我们要设计自己想要的记录属性,采集笑话,需要“标题”“内容”“分类”三个属性,如图9所示内容标签定义

图9 内容标签定义

具体到各个标签的规则定义如下图10-13:

图10 前后截取形式抽取标题

图11 可视化抽取内容

需要注意的是,在内容抽取过程中可能会遇见一些html标签残留,或者是双引号,感叹号以及省略号等等不显示,这时候我们可以按照须要进行html标签排除和一些字符的替换。

图12 可视化提取分类

图13 规则测试

三、抓数据

通过以上“网址采集规则”和“内容采集规则”的设置,就可以开始任务了。经过一段时间,数据采集完成,我们可以对任务进行右单击选择“打开Data下任务文件夹”,就可以看见默认为Access的数据文件,当然也可以转换为Excel格式。由于排重的时侯我们是以Excel格式进行数据输入的,所以我们将其转换为Excel格式。

第二部份 笑话排重

算法思想:本次笑话排重,主要是从内容上判定。采用MD5摘要算法,我们选定第一个句话前后7个字符进行MD5码运算,就是英文“。”和英语“.”前面4个前面两个再加本身7个字符进行MD5运算,没有英文句号和英语句号的暂时定为不重复。然后对比比每条笑话的前七个字符的MD5码。根据“select*,count(distinct Md5)from mo1 group by Md5”将和现有的笑话重复的笑话排除掉。

算法描述:MD5对以512位为单位的输入进行变换最终以32位为单位4个的压缩信息组输出。根据运算结果的唯一性,我们可以每条笑话的第一个句号的前7个字符进行相同MD5运算,比对过后进行确认是否相同。

MD5过程描述如图14

图14 MD5过程

算法实现:

1、input

import MySQLdb

import xlrd

conn = MySQLdb.connect(host='localhost' , user = 'root',passwd='root' ,db = 'joke' ,use_unicode=True,charset='utf8')

cursor = conn.cursor()

data = xlrd.open_workbook('E:\joke1.xls')

table = data.sheets()[0]

cursor.execute('select *,count(distinct Md5)from mo1 group byMd5;')

rows = cursor.fetchall()

for row in rows:

k = row[0]

a = int(table.cell(k,0).value)

b = table.cell(k,1).value

c = table.cell(k,2).value

d = table.cell(k,3).value

e = table.cell(k,4).value

f = table.cell(k,5).value

g = table.cell(k,6).value

sql = 'INSERT INTO jo1values(%s,%s,%s,%s,%s,%s,%s)'

cursor.execute(sql,(a,b,c,d,e,f,g))

cursor.close()

mit()

2、MD5算法代码实现

# -*- coding: UTF-8 -*-

import xlrd

import re

import hashlib

import MySQLdb

data = xlrd.open_workbook('E:\joke1.xls')

table = data.sheets()[0]

conn = MySQLdb.connect(host='localhost' , user = 'root',passwd='root' ,db = 'joke' ,use_unicode=True,charset='utf8')

cursor = conn.cursor()

for n in range(1,table.nrows):

a = table.cell(n,4).value

print n

md =''

for i in range(len(a)):

s = ''

if a[i] == u'.':

print a[i]

if i ==len(a)-1:

j =len(a)

elif i ==len(a)-2:

j =len(a)

else:

j =i+3

for k inrange(j-7,j):

s =s+a[k]

m =hashlib.md5(s.encode('utf8'))

md =m.hexdigest()

break

elif a[i] == u'。':

print a[i]

if i ==len(a)-1:

j =len(a)

elif i ==len(a)-2:

j =len(a)

else:

j =i+3

for k inrange(j-7,j):

s =s+a[k]

m =hashlib.md5(s.encode('utf8'))

md =m.hexdigest() 查看全部

互联网上笑话抽取及排重---优采云采集器的使用和MD5算法的应用

图2 编辑任务

下面学习过程介绍均以开心驿站为例表述

第一步:采集网址规则

首先要先添加起始网址 接下来的笑话网址采集就分为两种形式。

第一种就是在“添加开始采集地址”窗体中设置“批量/多页”项,设置“等差数列”方式,即采集的笑话从第一页到最后一页,这些页数是成公差为1的等差数列,如图3所示

图3 批量/多页设置

将“开心驿站”上面各种笑话设置完全,效果图如图3所示

图4 起始网址效果图

当然,如果仅此设置的话,我们一页只能采到一条笑话,实际上,“开心驿站”上面的一页可以显示16条笑话,这样我们还要设置一下“多级网址采集规则”。可以自动剖析页面html格式,然后填写规则,这里采用最简单的可视化Xpath方法获取地址。如图5所示

图5 Xpath方法获取地址

我们可以看出多级网址获取方法为get如图6所示

图6 多级网址设置效果图

第二种就是不在设置“批量/多页”,而是直接设置“多级网址获取”,首先获得“开心驿站”上面各个分类的默认打开地址。

例如“校园笑话”,这些网址的获取,我们同样采用的是最简单的可视化地址Xpath方法获得。Xpath获得的网址上面有可能不是我们想要的网址,比如list10-1和list13-1分别为图片和视频,所以我们可以进行“结果网址过滤”如图7所示

图7 结果网址过滤设置

接下来就是“列表分页获取”设置,这个就是对每位分类的默认页进行下一页的采集,根据html上面的格式,我们如图8所示设置

图8 列表分页获取设置

至于每一页要采集到16条笑话的网址,这个就和第一种方法是一样的。就此略过。

第二步 采集内容规则

首先我们要设计自己想要的记录属性,采集笑话,需要“标题”“内容”“分类”三个属性,如图9所示内容标签定义

图9 内容标签定义

具体到各个标签的规则定义如下图10-13:

图10 前后截取形式抽取标题

图11 可视化抽取内容

需要注意的是,在内容抽取过程中可能会遇见一些html标签残留,或者是双引号,感叹号以及省略号等等不显示,这时候我们可以按照须要进行html标签排除和一些字符的替换。

图12 可视化提取分类

图13 规则测试

三、抓数据

通过以上“网址采集规则”和“内容采集规则”的设置,就可以开始任务了。经过一段时间,数据采集完成,我们可以对任务进行右单击选择“打开Data下任务文件夹”,就可以看见默认为Access的数据文件,当然也可以转换为Excel格式。由于排重的时侯我们是以Excel格式进行数据输入的,所以我们将其转换为Excel格式。

第二部份 笑话排重

算法思想:本次笑话排重,主要是从内容上判定。采用MD5摘要算法,我们选定第一个句话前后7个字符进行MD5码运算,就是英文“。”和英语“.”前面4个前面两个再加本身7个字符进行MD5运算,没有英文句号和英语句号的暂时定为不重复。然后对比比每条笑话的前七个字符的MD5码。根据“select*,count(distinct Md5)from mo1 group by Md5”将和现有的笑话重复的笑话排除掉。

算法描述:MD5对以512位为单位的输入进行变换最终以32位为单位4个的压缩信息组输出。根据运算结果的唯一性,我们可以每条笑话的第一个句号的前7个字符进行相同MD5运算,比对过后进行确认是否相同。

MD5过程描述如图14

图14 MD5过程

算法实现:

1、input

import MySQLdb

import xlrd

conn = MySQLdb.connect(host='localhost' , user = 'root',passwd='root' ,db = 'joke' ,use_unicode=True,charset='utf8')

cursor = conn.cursor()

data = xlrd.open_workbook('E:\joke1.xls')

table = data.sheets()[0]

cursor.execute('select *,count(distinct Md5)from mo1 group byMd5;')

rows = cursor.fetchall()

for row in rows:

k = row[0]

a = int(table.cell(k,0).value)

b = table.cell(k,1).value

c = table.cell(k,2).value

d = table.cell(k,3).value

e = table.cell(k,4).value

f = table.cell(k,5).value

g = table.cell(k,6).value

sql = 'INSERT INTO jo1values(%s,%s,%s,%s,%s,%s,%s)'

cursor.execute(sql,(a,b,c,d,e,f,g))

cursor.close()

mit()

2、MD5算法代码实现

# -*- coding: UTF-8 -*-

import xlrd

import re

import hashlib

import MySQLdb

data = xlrd.open_workbook('E:\joke1.xls')

table = data.sheets()[0]

conn = MySQLdb.connect(host='localhost' , user = 'root',passwd='root' ,db = 'joke' ,use_unicode=True,charset='utf8')

cursor = conn.cursor()

for n in range(1,table.nrows):

a = table.cell(n,4).value

print n

md =''

for i in range(len(a)):

s = ''

if a[i] == u'.':

print a[i]

if i ==len(a)-1:

j =len(a)

elif i ==len(a)-2:

j =len(a)

else:

j =i+3

for k inrange(j-7,j):

s =s+a[k]

m =hashlib.md5(s.encode('utf8'))

md =m.hexdigest()

break

elif a[i] == u'。':

print a[i]

if i ==len(a)-1:

j =len(a)

elif i ==len(a)-2:

j =len(a)

else:

j =i+3

for k inrange(j-7,j):

s =s+a[k]

m =hashlib.md5(s.encode('utf8'))

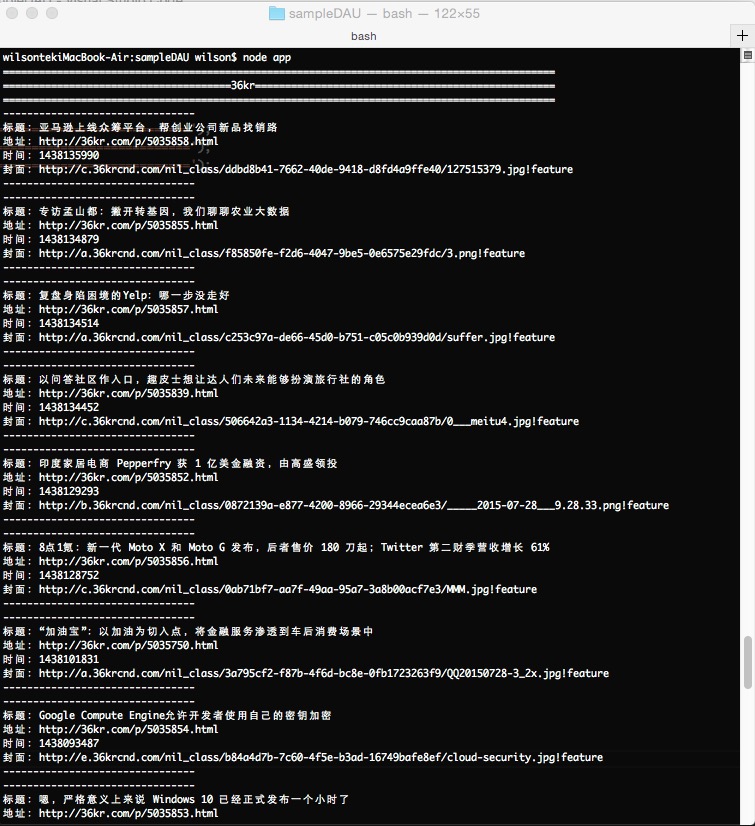

md =m.hexdigest()

无规则采集器列表算法 Nodejs学习笔记(十一)

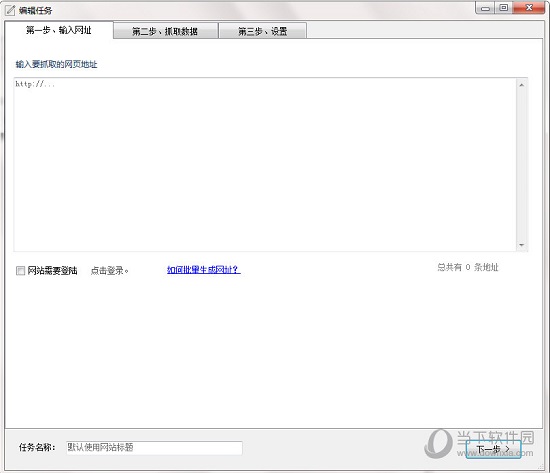

采集交流 • 优采云 发表了文章 • 0 个评论 • 510 次浏览 • 2020-08-25 21:01

目录写在之前

很多人都有做数据采集的需求,用不同的语言,不同的方法都能实现,我曾经也用C#写过,主要还是发送各种恳求和正则解析数据比较冗长些,总体来说没啥不好的,就是效率要差一些,

用nodejs写采集程序还是比较有效率(可能也只是相对C#来说),今天主要用一个示例来说一下使用nodejs实现数据采集器,主要使用到request和cheerio。

request :用于http请求

cheerio:用于提取request返回的html中须要的信息(和jquery用法一致)

示例

单独去说API用法没哪些意思也没必要记住全部API,下面开始示例

还是说点闲谈:

nodejs开发工具还是好多,以前我也太推荐sublime,自从谷歌推出了Visual Studio Code后就转用它去做nodejs开发。

用它开发还是比较舒服的,免配置、启动快、自动补全、查看定义和引用、搜索快等,有VS的一贯风格,应该会越做越好,所以推荐一下^_^!

示例要求

从 中抓取其中文章的“标题”、“地址”、“发布时间”、“封面图片”

采集器

1.建立项目文件夹sampleDAU

2.建立package.json文件

{

"name": "Wilson_SampleDAU",

"version": "0.0.1",

"private": false,

"dependencies": {

"request":"*",

"cheerio":"*"

}

}

3.在终端中用npm安装引用

cd 项目根目录

npm install

4.建立app.js编撰采集器代码

首先要用浏览器打开要采集的URL,使用开发者工具查看HTML结构,然后按照结构写解析代码

/*

* 功能: 数据采集

* 创建人: Wilson

* 时间: 2015-07-29

*/

var request = require('request'),

cheerio = require('cheerio'),

URL_36KR = 'http://36kr.com/'; //36氪

/* 开启数据采集器 */

function dataCollectorStartup() {

dataRequest(URL_36KR);

}

/* 数据请求 */

function dataRequest(dataUrl)

{

request({

url: dataUrl,

method: 'GET'

}, function(err, res, body) {

if (err) {

console.log(dataUrl)

console.error('[ERROR]Collection' + err);

return;

}

switch(dataUrl)

{

case URL_36KR:

dataParse36Kr(body);

break;

}

});

}

/* 36kr 数据解析 */

function dataParse36Kr(body)

{

console.log('============================================================================================');

console.log('======================================36kr==================================================');

console.log('============================================================================================');

var $ = cheerio.load(body);

var articles = $('article')

for (var i = 0; i < articles.length; i++) {

var article = articles[i];

var descDoms = $(article).find('.desc');

if(descDoms.length == 0)

{

continue;

}

var coverDom = $(article).children().first();

var titleDom = $(descDoms).find('.info_flow_news_title');

var timeDom = $(descDoms).find('.timeago');

var titleVal = titleDom.text();

var urlVal = titleDom.attr('href');

var timeVal = timeDom.attr('title');

var coverUrl = coverDom.attr('data-lazyload');

//处理时间

var timeDateSecs = new Date(timeVal).getTime() / 1000;

if(urlVal != undefined)

{

console.info('--------------------------------');

console.info('标题:' + titleVal);

console.info('地址:' + urlVal);

console.info('时间:' + timeDateSecs);

console.info('封面:' + coverUrl);

console.info('--------------------------------');

}

};

}

dataCollectorStartup();

测试结果

这个采集器就完成了,其实就是request一个get恳求,请求反弹中会返回body即HTML代码,通过cheerio库以jquery库句型一样操作解析,取出想要的数据!

加入代理

做一个采集器DEMO里面就基本完成了。如果须要常年使用为了避免网站屏蔽,还是须要加入一个代理列表

为示例我从网上的免费代理中提出一些做示例,制作成proxylist.js,其中提供一个随机取一条代理的函数

var PROXY_LIST = [{"ip":"111.1.55.136","port":"55336"},{"ip":"111.1.54.91","port":"55336"},{"ip":"111.1.56.19","port":"55336"}

,{"ip":"112.114.63.16","port":"55336"},{"ip":"106.58.63.83","port":"55336"},{"ip":"119.188.133.54","port":"55336"}

,{"ip":"106.58.63.84","port":"55336"},{"ip":"183.95.132.171","port":"55336"},{"ip":"11.12.14.9","port":"55336"}

,{"ip":"60.164.223.16","port":"55336"},{"ip":"117.185.13.87","port":"8080"},{"ip":"112.114.63.20","port":"55336"}

,{"ip":"188.134.19.102","port":"3129"},{"ip":"106.58.63.80","port":"55336"},{"ip":"60.164.223.20","port":"55336"}

,{"ip":"106.58.63.78","port":"55336"},{"ip":"112.114.63.23","port":"55336"},{"ip":"112.114.63.30","port":"55336"}

,{"ip":"60.164.223.14","port":"55336"},{"ip":"190.202.82.234","port":"3128"},{"ip":"60.164.223.15","port":"55336"}

,{"ip":"60.164.223.5","port":"55336"},{"ip":"221.204.9.28","port":"55336"},{"ip":"60.164.223.2","port":"55336"}

,{"ip":"139.214.113.84","port":"55336"} ,{"ip":"112.25.49.14","port":"55336"},{"ip":"221.204.9.19","port":"55336"}

,{"ip":"221.204.9.39","port":"55336"},{"ip":"113.207.57.18","port":"55336"} ,{"ip":"112.25.62.15","port":"55336"}

,{"ip":"60.5.255.143","port":"55336"},{"ip":"221.204.9.18","port":"55336"},{"ip":"60.5.255.145","port":"55336"}

,{"ip":"221.204.9.16","port":"55336"},{"ip":"183.232.82.132","port":"55336"},{"ip":"113.207.62.78","port":"55336"}

,{"ip":"60.5.255.144","port":"55336"} ,{"ip":"60.5.255.141","port":"55336"},{"ip":"221.204.9.23","port":"55336"}

,{"ip":"157.122.96.50","port":"55336"},{"ip":"218.61.39.41","port":"55336"} ,{"ip":"221.204.9.26","port":"55336"}

,{"ip":"112.112.43.213","port":"55336"},{"ip":"60.5.255.138","port":"55336"},{"ip":"60.5.255.133","port":"55336"}

,{"ip":"221.204.9.25","port":"55336"},{"ip":"111.161.35.56","port":"55336"},{"ip":"111.161.35.49","port":"55336"}

,{"ip":"183.129.134.226","port":"8080"} ,{"ip":"58.220.10.86","port":"80"},{"ip":"183.87.117.44","port":"80"}

,{"ip":"211.23.19.130","port":"80"},{"ip":"61.234.249.107","port":"8118"},{"ip":"200.20.168.140","port":"80"}

,{"ip":"111.1.46.176","port":"55336"},{"ip":"120.203.158.149","port":"8118"},{"ip":"70.39.189.6","port":"9090"}

,{"ip":"210.6.237.191","port":"3128"},{"ip":"122.155.195.26","port":"8080"}];

module.exports.GetProxy = function () {

var randomNum = parseInt(Math.floor(Math.random() * PROXY_LIST.length));

var proxy = PROXY_LIST[randomNum];

return 'http://' + proxy.ip + ':' + proxy.port;

}

proxylist.js

对app.js代码做如下更改

/*

* 功能: 数据采集

* 创建人: Wilson

* 时间: 2015-07-29

*/

var request = require('request'),

cheerio = require('cheerio'),

URL_36KR = 'http://36kr.com/', //36氪

Proxy = require('./proxylist.js');

...

/* 数据请求 */

function dataRequest(dataUrl)

{

request({

url: dataUrl,

proxy: Proxy.GetProxy(),

method: 'GET'

}, function(err, res, body) {

...

}

}

...

dataCollectorStartup()

setInterval(dataCollectorStartup, 10000);

这样就改建完成,加入代码,并且加了setInterval进行定间隔执行! 查看全部

无规则采集器列表算法 Nodejs学习笔记(十一)

目录写在之前

很多人都有做数据采集的需求,用不同的语言,不同的方法都能实现,我曾经也用C#写过,主要还是发送各种恳求和正则解析数据比较冗长些,总体来说没啥不好的,就是效率要差一些,

用nodejs写采集程序还是比较有效率(可能也只是相对C#来说),今天主要用一个示例来说一下使用nodejs实现数据采集器,主要使用到request和cheerio。

request :用于http请求

cheerio:用于提取request返回的html中须要的信息(和jquery用法一致)

示例

单独去说API用法没哪些意思也没必要记住全部API,下面开始示例

还是说点闲谈:

nodejs开发工具还是好多,以前我也太推荐sublime,自从谷歌推出了Visual Studio Code后就转用它去做nodejs开发。

用它开发还是比较舒服的,免配置、启动快、自动补全、查看定义和引用、搜索快等,有VS的一贯风格,应该会越做越好,所以推荐一下^_^!

示例要求

从 中抓取其中文章的“标题”、“地址”、“发布时间”、“封面图片”

采集器

1.建立项目文件夹sampleDAU

2.建立package.json文件

{

"name": "Wilson_SampleDAU",

"version": "0.0.1",

"private": false,

"dependencies": {

"request":"*",

"cheerio":"*"

}

}

3.在终端中用npm安装引用

cd 项目根目录

npm install

4.建立app.js编撰采集器代码

首先要用浏览器打开要采集的URL,使用开发者工具查看HTML结构,然后按照结构写解析代码

/*

* 功能: 数据采集

* 创建人: Wilson

* 时间: 2015-07-29

*/

var request = require('request'),

cheerio = require('cheerio'),

URL_36KR = 'http://36kr.com/'; //36氪

/* 开启数据采集器 */

function dataCollectorStartup() {

dataRequest(URL_36KR);

}

/* 数据请求 */

function dataRequest(dataUrl)

{

request({

url: dataUrl,

method: 'GET'

}, function(err, res, body) {

if (err) {

console.log(dataUrl)

console.error('[ERROR]Collection' + err);

return;

}

switch(dataUrl)

{

case URL_36KR:

dataParse36Kr(body);

break;

}

});

}

/* 36kr 数据解析 */

function dataParse36Kr(body)

{

console.log('============================================================================================');

console.log('======================================36kr==================================================');

console.log('============================================================================================');

var $ = cheerio.load(body);

var articles = $('article')

for (var i = 0; i < articles.length; i++) {

var article = articles[i];

var descDoms = $(article).find('.desc');

if(descDoms.length == 0)

{

continue;

}

var coverDom = $(article).children().first();

var titleDom = $(descDoms).find('.info_flow_news_title');

var timeDom = $(descDoms).find('.timeago');

var titleVal = titleDom.text();

var urlVal = titleDom.attr('href');

var timeVal = timeDom.attr('title');

var coverUrl = coverDom.attr('data-lazyload');

//处理时间

var timeDateSecs = new Date(timeVal).getTime() / 1000;

if(urlVal != undefined)

{

console.info('--------------------------------');

console.info('标题:' + titleVal);

console.info('地址:' + urlVal);

console.info('时间:' + timeDateSecs);

console.info('封面:' + coverUrl);

console.info('--------------------------------');

}

};

}

dataCollectorStartup();

测试结果

这个采集器就完成了,其实就是request一个get恳求,请求反弹中会返回body即HTML代码,通过cheerio库以jquery库句型一样操作解析,取出想要的数据!

加入代理

做一个采集器DEMO里面就基本完成了。如果须要常年使用为了避免网站屏蔽,还是须要加入一个代理列表

为示例我从网上的免费代理中提出一些做示例,制作成proxylist.js,其中提供一个随机取一条代理的函数

var PROXY_LIST = [{"ip":"111.1.55.136","port":"55336"},{"ip":"111.1.54.91","port":"55336"},{"ip":"111.1.56.19","port":"55336"}

,{"ip":"112.114.63.16","port":"55336"},{"ip":"106.58.63.83","port":"55336"},{"ip":"119.188.133.54","port":"55336"}

,{"ip":"106.58.63.84","port":"55336"},{"ip":"183.95.132.171","port":"55336"},{"ip":"11.12.14.9","port":"55336"}

,{"ip":"60.164.223.16","port":"55336"},{"ip":"117.185.13.87","port":"8080"},{"ip":"112.114.63.20","port":"55336"}

,{"ip":"188.134.19.102","port":"3129"},{"ip":"106.58.63.80","port":"55336"},{"ip":"60.164.223.20","port":"55336"}

,{"ip":"106.58.63.78","port":"55336"},{"ip":"112.114.63.23","port":"55336"},{"ip":"112.114.63.30","port":"55336"}

,{"ip":"60.164.223.14","port":"55336"},{"ip":"190.202.82.234","port":"3128"},{"ip":"60.164.223.15","port":"55336"}

,{"ip":"60.164.223.5","port":"55336"},{"ip":"221.204.9.28","port":"55336"},{"ip":"60.164.223.2","port":"55336"}

,{"ip":"139.214.113.84","port":"55336"} ,{"ip":"112.25.49.14","port":"55336"},{"ip":"221.204.9.19","port":"55336"}

,{"ip":"221.204.9.39","port":"55336"},{"ip":"113.207.57.18","port":"55336"} ,{"ip":"112.25.62.15","port":"55336"}

,{"ip":"60.5.255.143","port":"55336"},{"ip":"221.204.9.18","port":"55336"},{"ip":"60.5.255.145","port":"55336"}

,{"ip":"221.204.9.16","port":"55336"},{"ip":"183.232.82.132","port":"55336"},{"ip":"113.207.62.78","port":"55336"}

,{"ip":"60.5.255.144","port":"55336"} ,{"ip":"60.5.255.141","port":"55336"},{"ip":"221.204.9.23","port":"55336"}

,{"ip":"157.122.96.50","port":"55336"},{"ip":"218.61.39.41","port":"55336"} ,{"ip":"221.204.9.26","port":"55336"}

,{"ip":"112.112.43.213","port":"55336"},{"ip":"60.5.255.138","port":"55336"},{"ip":"60.5.255.133","port":"55336"}

,{"ip":"221.204.9.25","port":"55336"},{"ip":"111.161.35.56","port":"55336"},{"ip":"111.161.35.49","port":"55336"}

,{"ip":"183.129.134.226","port":"8080"} ,{"ip":"58.220.10.86","port":"80"},{"ip":"183.87.117.44","port":"80"}

,{"ip":"211.23.19.130","port":"80"},{"ip":"61.234.249.107","port":"8118"},{"ip":"200.20.168.140","port":"80"}

,{"ip":"111.1.46.176","port":"55336"},{"ip":"120.203.158.149","port":"8118"},{"ip":"70.39.189.6","port":"9090"}

,{"ip":"210.6.237.191","port":"3128"},{"ip":"122.155.195.26","port":"8080"}];

module.exports.GetProxy = function () {

var randomNum = parseInt(Math.floor(Math.random() * PROXY_LIST.length));

var proxy = PROXY_LIST[randomNum];

return 'http://' + proxy.ip + ':' + proxy.port;

}

proxylist.js

对app.js代码做如下更改

/*

* 功能: 数据采集

* 创建人: Wilson

* 时间: 2015-07-29

*/

var request = require('request'),

cheerio = require('cheerio'),

URL_36KR = 'http://36kr.com/', //36氪

Proxy = require('./proxylist.js');

...

/* 数据请求 */

function dataRequest(dataUrl)

{

request({

url: dataUrl,

proxy: Proxy.GetProxy(),

method: 'GET'

}, function(err, res, body) {

...

}

}

...

dataCollectorStartup()

setInterval(dataCollectorStartup, 10000);

这样就改建完成,加入代码,并且加了setInterval进行定间隔执行!

优采云采集器无限制免费版V3.4.5 下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 681 次浏览 • 2020-08-25 16:21

优采云采集器破解版是款十分实用的网页数据采集工具,这软件就能快速采集网页数据,将所有的数据进行导入,使用上去十分方便,喜欢的用户们千万不要错过哦!

软件介绍

优采云采集器这软件功能性还是挺强的,软件里你只需输入相关的网址才能手动采集里面的内容,软件里可以导入本地文件进行发布。软件才能将所有的数据进行同步,可以通过批量采集数据来进行体验。软件可以按照不同的网站类型,导出你须要的内容。

优采云采集器深受到用户们的关注,你可以在软件里添加须要抽取的文本、链接及各类不同的属性标签,这样就能快速增强软件采集速度,提高工作效率,有需求的用户们还在等哪些呢?

软件功能

一、【规则配置简单 采集功能强悍】

1、可视化自定义采集流程:

全程问答式引导、可视化操作、自定义采集流程

自动记录和模拟网页操作次序

高级设置满足更多采集需求

2、点选抽取网页数据:

鼠标点击选择要爬取的网页内容、操作简单

可选择抽取文本、链接、属性、html标签等

3、运行批量采集数据:

软件根据采集流程和抽取规则手动批量采集

快速稳定,实时显示采集速度和过程

可切换软件后台运行,不打搅前台工作

4、导出和发布采集的数据:

采集的数据手动表格化,自由配置数组

支持数据导入到Excel等本地文件

和一键发布到CMS网站/数据库/微信公众号等媒体

二、【支持采集不同类型的网站】

电商类、生活服务类、社交媒体、新闻峰会、地方网站......

强大浏览器内核,99%以上网站都能采!

三、【全平台支持 全免费 可视化操作】

支持所有操作系统:Windows+Mac+Linux

采集和导入全免费,无限制放心用

可视化配置采集规则,傻瓜式操作

四、【功能强悍,箭速迭】

智能辨识网页数据,导出数据形式多样

软件定期更新升级,不断添加新功能

客户的满意是对我们最大的肯定!

软件特色

智能辨识数据,小白利器

智能模式:基于人工智能算法,只需输入网址能够智能辨识列表数据、表格数据和分页按键,不需要配置任何采集规则,一键采集。

自动辨识:列表、表格、链接、图片、价格、邮箱等

支持多种数据导入方法

采集结果可以导入到本地,支持TXT、EXCEL、CSV和HTML文件格式,也可以直接发布到数据库(MySQL、MongoDB、SQL Server、PostgreSQL)和网站(Wordpress、Discuz等),提供丰富的发布插件供您使用。

可视化点击,简单上手

流程图模式:只需按照软件提示在页面中进行点击操作,完全符合人为浏览网页的思维方法,简单几步即可生成复杂的采集规则,结合智能辨识算法,任何网页的数据都能轻松采集。

可模拟操作: 输入文本、点击、移动滑鼠、下拉框、滚动页面、等待加载、循环操作和判别条件等。

功能强悍,提供企业级服务

优采云采集器提供丰富的采集功能,无论是采集稳定性或是采集效率,都还能满足个人、团队和企业级采集需求。

丰富的功能: 定时采集,智能防屏蔽,自动导入,文件下载,加速引擎,按组启动和导入,Webhook,RESTful API,智能辨识SKU和电商大图等。

云端帐号,方便快捷

创建优采云采集器帐号并登陆,您的所有采集任务都将手动同步保存到优采云的云端服务器,无需害怕采集任务遗失。 优采云采集器对帐号没有终端绑定限制,您切换终端时采集任务也会同步更新,任务管理便捷快捷。

全平台支持,无缝切换

同时支持Windows、Mac和Linux全操作系统的采集软件,各平台版本完全相同,无缝切换。

怎么导入

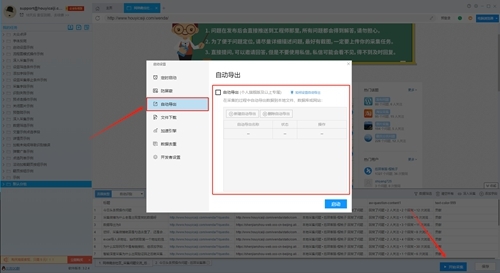

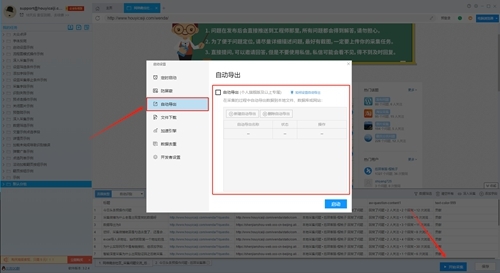

开启手动导入有两种形式:

第一种是直接在启动任务时进行设置,这种设置方法可以对同一个采集任务添加多个手动导入。

在编辑任务界面,点击右下角“开始采集”按钮,在弹出的设置框中,点击“自动导入”选项可以切换到手动导入设置界面。

勾选“自动导入”功能,点击“新建手动导入”按钮,新建手动导入的设置。

点击这个按键后,软件会打开导入设置界面,在该界面中我们可以选择具体的导入方法。优采云采集器支持导入到本地文件、数据库和网站中。

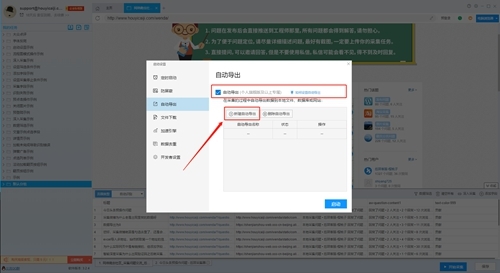

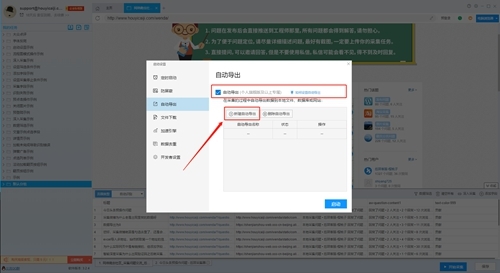

第二种是任务运行界面进行设置,这种设置方法只能添加一个手动导入。

在任务运行界面,点击右上方手动导入的开关按键可以直接设置手动导入。

点击打开开关后,会直接跳出导入设置框,具体设置方法根据下文教程即可。

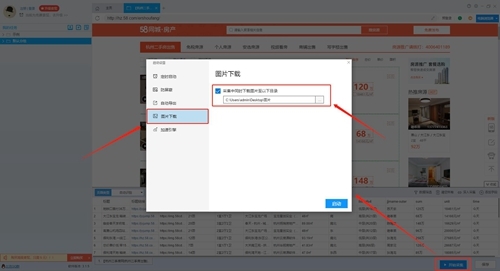

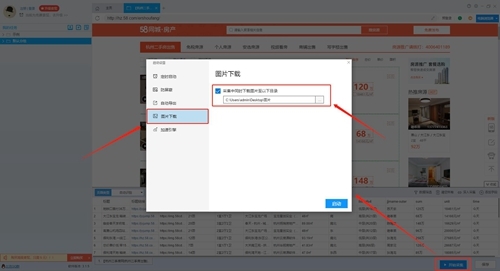

怎么下载图片

下载图片有以下两种形式:

第一种:逐个图片添加

我们须要添加一个数组,然后在页面中点击我们要下载的图片。

然后右击数组,修改数组属性为“提取图片地址”

第二种:一次下载多个图片

这种情况须要图片集中在一起,可以一次框选所有图片。

我们可以添加一个数组,然后去页面中点击整个图片区域的右下角,在框选时我们可以看见软件的白色框选区域,保证所有要下载的图片都被框选到。

然后右击数组,修改数组属性为“提取内部HTML”。

接下来我们只需点击“开始采集”,然后在启动框中勾选“采集中同时下载图片至以下目录”即可开启图片下载功能,用户可以设置图片的本地保存路径。

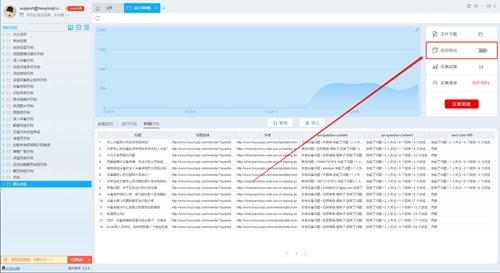

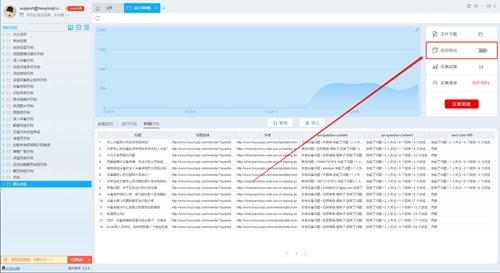

如何提高速率

优采云采集器的加速引擎功能可以对采集任务进行加速,加速疗效和网页加载速率以及采集任务的设置有关,通常可以达到3~10倍的加速疗效。

加速引擎的加速选项包括:智能恳求、智能跳过详情页、多线程采集、禁用多媒体和HTTP引擎。

大家可以在启动任务时进行设置,软件会按照您的设置启动对应的加速功能。

如果您在开启任务时没有使用加速引擎,在任务运行界面中也可以通过点击加速按键来开启加速功能。

使用说明

自定义采集百度搜索结果数据的方式

步骤1:创建采集任务

1)启动优采云采集器,进入主界面,选择自定义采集并点击创建任务按键创建 "自定义采集任务"

2)输入百度搜索的URL,包括三种形式

1、手动输入:在输入框中直接输入URL,多个URL时需要换行分割

2、点击从文件中读取方法:用户选择一个储存URL的文件,文件中可以有多个URL地址,地址需要换行分割。

3、批量添加方法:通过添加并调整地址参数生成多个有规律的地址

步骤2:自定义采集流程

1)点击创建后手动打开第一个URL因而步入自定义设置页面,默认早已创建了开始、打开网页、结束的流程块。底部模板市用于拖放到画布中生成新的流程块;点击打开网页中的属性按键,可更改打开的网址

2)添加输入文字流程块:在顶部模板市中拖放输入文字块到打开网页块前面附近,当出现阴影区域的时侯可以握住键盘,此时会手动联接,添加完成

3)生成完整流程图:仿照里面添加输入文字流程块的拖放流程添加新块

关键步骤块设置介绍:

1.定时等待用于等待上面打开网页完成

2.点击输入框Xpath属性按键,在属性菜单中点击图标进行点选网页中的输入框,点击输入文本属性按键,在菜单中输入要搜索的文本。

3.用于设置点击开始搜索按键,点击元素的xpath属性按键,在菜单中点击点选图标,然后点击网页中的百度一下按键即可。

4.用于设置循环加载下一列表页。在循环块内部的循环条件块中设置详尽条件,此处点击操作按键,选择单个元素,然后在属性菜单中点击元素的xpath属性按键,同上进行点选网页中的下一页按键。循环次数属性按键可默认为0,即不限制点击下一页的次数。

5.用于设置循环抽取列表页中的数据。在循环块内部的循环条件块中设置详尽条件,此处点击操作按键,选择不固定元素列表,然后在属性菜单中点击元素的xpath属性按键,然后在网页中连续点选两次抽取第一块和第二块元素。循环次数属性按键可默认为0,即不限制列表中缴纳数组的数目。

6.用于执行点击下一页按键操作,点击元素xpath属性按键,选择使用当前循环中元素的xpath选项。

7.同理用于设置网页加载等待时间。

8.用于设置在列表页抽取的数组规则,点击属性按键中使用循环中的元素按键,选择使用循环中的元素选项。点击元素模板属性按键在数组表格中点击加减进行添加删掉数组,添加数组使用点选操作,即点击减号后键盘联通到网页元素上点击选择。

4)点击开始采集,启动采集

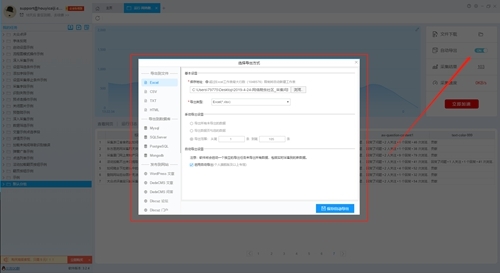

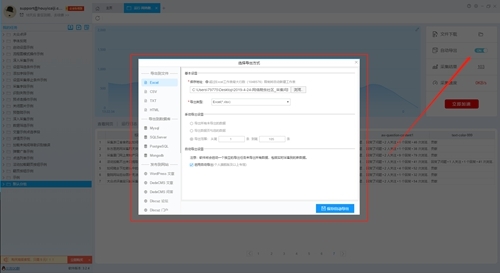

数据采集及导入

1)采集任务运行中

2)采集完成后,选择“导出数据”可以把数据都导入到本地文件

3)选择“导出方法”,将采集好的数据导入,这里可以选择excel作为导入为格式

4)采集数据导入后 查看全部

优采云采集器无限制免费版V3.4.5 下载

优采云采集器破解版是款十分实用的网页数据采集工具,这软件就能快速采集网页数据,将所有的数据进行导入,使用上去十分方便,喜欢的用户们千万不要错过哦!

软件介绍

优采云采集器这软件功能性还是挺强的,软件里你只需输入相关的网址才能手动采集里面的内容,软件里可以导入本地文件进行发布。软件才能将所有的数据进行同步,可以通过批量采集数据来进行体验。软件可以按照不同的网站类型,导出你须要的内容。

优采云采集器深受到用户们的关注,你可以在软件里添加须要抽取的文本、链接及各类不同的属性标签,这样就能快速增强软件采集速度,提高工作效率,有需求的用户们还在等哪些呢?

软件功能

一、【规则配置简单 采集功能强悍】

1、可视化自定义采集流程:

全程问答式引导、可视化操作、自定义采集流程

自动记录和模拟网页操作次序

高级设置满足更多采集需求

2、点选抽取网页数据:

鼠标点击选择要爬取的网页内容、操作简单

可选择抽取文本、链接、属性、html标签等

3、运行批量采集数据:

软件根据采集流程和抽取规则手动批量采集

快速稳定,实时显示采集速度和过程

可切换软件后台运行,不打搅前台工作

4、导出和发布采集的数据:

采集的数据手动表格化,自由配置数组

支持数据导入到Excel等本地文件

和一键发布到CMS网站/数据库/微信公众号等媒体

二、【支持采集不同类型的网站】

电商类、生活服务类、社交媒体、新闻峰会、地方网站......

强大浏览器内核,99%以上网站都能采!

三、【全平台支持 全免费 可视化操作】

支持所有操作系统:Windows+Mac+Linux

采集和导入全免费,无限制放心用

可视化配置采集规则,傻瓜式操作

四、【功能强悍,箭速迭】

智能辨识网页数据,导出数据形式多样

软件定期更新升级,不断添加新功能

客户的满意是对我们最大的肯定!

软件特色

智能辨识数据,小白利器

智能模式:基于人工智能算法,只需输入网址能够智能辨识列表数据、表格数据和分页按键,不需要配置任何采集规则,一键采集。

自动辨识:列表、表格、链接、图片、价格、邮箱等

支持多种数据导入方法

采集结果可以导入到本地,支持TXT、EXCEL、CSV和HTML文件格式,也可以直接发布到数据库(MySQL、MongoDB、SQL Server、PostgreSQL)和网站(Wordpress、Discuz等),提供丰富的发布插件供您使用。

可视化点击,简单上手

流程图模式:只需按照软件提示在页面中进行点击操作,完全符合人为浏览网页的思维方法,简单几步即可生成复杂的采集规则,结合智能辨识算法,任何网页的数据都能轻松采集。

可模拟操作: 输入文本、点击、移动滑鼠、下拉框、滚动页面、等待加载、循环操作和判别条件等。

功能强悍,提供企业级服务

优采云采集器提供丰富的采集功能,无论是采集稳定性或是采集效率,都还能满足个人、团队和企业级采集需求。

丰富的功能: 定时采集,智能防屏蔽,自动导入,文件下载,加速引擎,按组启动和导入,Webhook,RESTful API,智能辨识SKU和电商大图等。

云端帐号,方便快捷

创建优采云采集器帐号并登陆,您的所有采集任务都将手动同步保存到优采云的云端服务器,无需害怕采集任务遗失。 优采云采集器对帐号没有终端绑定限制,您切换终端时采集任务也会同步更新,任务管理便捷快捷。

全平台支持,无缝切换

同时支持Windows、Mac和Linux全操作系统的采集软件,各平台版本完全相同,无缝切换。

怎么导入

开启手动导入有两种形式:

第一种是直接在启动任务时进行设置,这种设置方法可以对同一个采集任务添加多个手动导入。

在编辑任务界面,点击右下角“开始采集”按钮,在弹出的设置框中,点击“自动导入”选项可以切换到手动导入设置界面。

勾选“自动导入”功能,点击“新建手动导入”按钮,新建手动导入的设置。

点击这个按键后,软件会打开导入设置界面,在该界面中我们可以选择具体的导入方法。优采云采集器支持导入到本地文件、数据库和网站中。

第二种是任务运行界面进行设置,这种设置方法只能添加一个手动导入。

在任务运行界面,点击右上方手动导入的开关按键可以直接设置手动导入。

点击打开开关后,会直接跳出导入设置框,具体设置方法根据下文教程即可。

怎么下载图片

下载图片有以下两种形式:

第一种:逐个图片添加

我们须要添加一个数组,然后在页面中点击我们要下载的图片。

然后右击数组,修改数组属性为“提取图片地址”

第二种:一次下载多个图片

这种情况须要图片集中在一起,可以一次框选所有图片。

我们可以添加一个数组,然后去页面中点击整个图片区域的右下角,在框选时我们可以看见软件的白色框选区域,保证所有要下载的图片都被框选到。

然后右击数组,修改数组属性为“提取内部HTML”。

接下来我们只需点击“开始采集”,然后在启动框中勾选“采集中同时下载图片至以下目录”即可开启图片下载功能,用户可以设置图片的本地保存路径。

如何提高速率

优采云采集器的加速引擎功能可以对采集任务进行加速,加速疗效和网页加载速率以及采集任务的设置有关,通常可以达到3~10倍的加速疗效。

加速引擎的加速选项包括:智能恳求、智能跳过详情页、多线程采集、禁用多媒体和HTTP引擎。

大家可以在启动任务时进行设置,软件会按照您的设置启动对应的加速功能。

如果您在开启任务时没有使用加速引擎,在任务运行界面中也可以通过点击加速按键来开启加速功能。

使用说明

自定义采集百度搜索结果数据的方式

步骤1:创建采集任务

1)启动优采云采集器,进入主界面,选择自定义采集并点击创建任务按键创建 "自定义采集任务"

2)输入百度搜索的URL,包括三种形式

1、手动输入:在输入框中直接输入URL,多个URL时需要换行分割

2、点击从文件中读取方法:用户选择一个储存URL的文件,文件中可以有多个URL地址,地址需要换行分割。

3、批量添加方法:通过添加并调整地址参数生成多个有规律的地址

步骤2:自定义采集流程

1)点击创建后手动打开第一个URL因而步入自定义设置页面,默认早已创建了开始、打开网页、结束的流程块。底部模板市用于拖放到画布中生成新的流程块;点击打开网页中的属性按键,可更改打开的网址

2)添加输入文字流程块:在顶部模板市中拖放输入文字块到打开网页块前面附近,当出现阴影区域的时侯可以握住键盘,此时会手动联接,添加完成

3)生成完整流程图:仿照里面添加输入文字流程块的拖放流程添加新块

关键步骤块设置介绍:

1.定时等待用于等待上面打开网页完成

2.点击输入框Xpath属性按键,在属性菜单中点击图标进行点选网页中的输入框,点击输入文本属性按键,在菜单中输入要搜索的文本。

3.用于设置点击开始搜索按键,点击元素的xpath属性按键,在菜单中点击点选图标,然后点击网页中的百度一下按键即可。

4.用于设置循环加载下一列表页。在循环块内部的循环条件块中设置详尽条件,此处点击操作按键,选择单个元素,然后在属性菜单中点击元素的xpath属性按键,同上进行点选网页中的下一页按键。循环次数属性按键可默认为0,即不限制点击下一页的次数。

5.用于设置循环抽取列表页中的数据。在循环块内部的循环条件块中设置详尽条件,此处点击操作按键,选择不固定元素列表,然后在属性菜单中点击元素的xpath属性按键,然后在网页中连续点选两次抽取第一块和第二块元素。循环次数属性按键可默认为0,即不限制列表中缴纳数组的数目。

6.用于执行点击下一页按键操作,点击元素xpath属性按键,选择使用当前循环中元素的xpath选项。

7.同理用于设置网页加载等待时间。

8.用于设置在列表页抽取的数组规则,点击属性按键中使用循环中的元素按键,选择使用循环中的元素选项。点击元素模板属性按键在数组表格中点击加减进行添加删掉数组,添加数组使用点选操作,即点击减号后键盘联通到网页元素上点击选择。

4)点击开始采集,启动采集

数据采集及导入

1)采集任务运行中

2)采集完成后,选择“导出数据”可以把数据都导入到本地文件

3)选择“导出方法”,将采集好的数据导入,这里可以选择excel作为导入为格式

4)采集数据导入后

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2020-08-25 06:39

1、看,实现舆情剖析预警起码应包括:数据信息采集、统计挖掘预测、结果展示三个阶段。(如图)图舆情剖析预警系统系统结构数安舆情监控系统系统特性自定义URL来源及采集频率可以设定采集的栏目、URL、更新时间、扫描间隔等,系统的扫描间隔最小可以设置成分钟,即每隔一分钟,系统将手动扫描目标信息源,以便及时发觉目标信息源的最新变化,并以最快的速度采集到本地。支持多种网页格式可以采集常见的静态网页(HTMLHTMSHTML)和动态网页(ASPPHPJSP),还可以采集网页中收录的图片信息。支持多种字符集编码系采集子系统才能手动辨识多种字符集编码,包括英文、英文、中文繁体、中文简体等,并可以统一转换为GBK编码格式。支持整个互联网采集舆情检测系统搜索模式是以国外著名互联网搜索引擎的结果为基础并借助采集器直接面向互联网订制内容进行直接采集,只须要输入搜索关键词就可以了。支持内容抽取辨识系统可对网页进行内容剖析和过滤,自动清除。

2、索可指定搜索条件,既增强信息采集的针对性,又扩大采集范围的广度,收到事半功倍功效。)配置符合我公司需求的监控源方案系统为提供舆情源监控方案,对背景、行业、作者、正文等信息项,并对具有连续性内容的多个网页内容进行手动合并,论坛贴子主题、回帖、点击量等手动提取。)结构化采集技术数安舆情监控系统对网页数据进行结构化的信息抽取和数据储存,以满足多维度的信息挖掘和统计须要。)全天候不间断监控数安舆情监控系统*全天候监控互联网信息,也可设定采集时间;实施中可以做到分钟级的采集更新。)采集信息预处理数安舆情监控系统系统对采集信息进行系列预处理操作:超链剖析、编码辨识、URL去重、锚文本处理、垃圾信息过滤、关键字抽取、关键信息提取、正文抽取、自动摘要,达到系统舆情智能剖析前状态。数安舆情监控系统舆情智能剖析技术)自动分类技术手动分类技术包括以下两中分类方法:A基于内容的文本自动分类B基于规则的文本分类)自动聚类技术基于相。

3、件的破坏力和传播趋势,为危机公关服务。、了解在或潜在中的地位:帮助洞悉其、产品、品牌影响力,了解人们正反两方面的意见,客观评价其行业地位;、追踪上下游产品、新产品和新技术:帮助追踪上下游产品,有助于控制生产成本;追踪新产品新技术,有助于技术部门对产品线的技术革新;、服务于市场部门:快速对行情、促销、畅销区域、活动等作出反应,有助于市场部门做短期的营运规划;系统生成的统计报表,是对市场作出的一般性归纳,有利于市场部门做中常年的市场取舍。数安舆情监控系统三大模块舆情剖析引擎舆情剖析引擎为系统的核心功能,其主要包括以下功能:热点辨识能力、自动分类、聚类分析、倾向性剖析与统计、主题跟踪、信息手动摘要功能、截取证据、趋势剖析、突发事件剖析、报警系统、统计报告。互联网信息采集采用元搜索与信息雷达技术。智能信息抽取技术主要是针对特殊进行特定领域的信息采集。搜索引擎数据管理搜索引擎数据管理功能主要包括以下功能:对搜集到信。

4、似性算法的自动聚类技术,自动对海量的无规则文档进行归类,把内容相仿的文档归为一类,并手动为其生成主题词,为确定类目名称提供便捷。)相似性检索和查重技术基于文档“指纹”的文本查重技术,支持海量数据的信息查重。相似性检索是在文本集合中查找出与之内容相像的其他文本的技术。在实际应用中找出舆情信息内容雷同文章,对相像、雷同文章消重处理;还依据文章主题相似性,生成专题报导,背景剖析等。自然语言智能处理技术)自动分词技术以辞典为基础,规则与统计相结合的动词技术,有效解决切分歧义。综合运用基于机率统计的语言模型方式,分词准确性达到%。)自动关键词和手动摘要技术对采集到的网路信息,自动摘取相关关键字,并生成摘要,并与快速浏览与检索。全文检索技术全文检索将传统的全文检索技术与最新的WEB搜索技术相结合,大大提高检索引擎的性能指标。还融合多种技术,提供丰富的检索手段以及同义词等智能检索方法。第三章施行方案总体框架从整体结构上。

5、息进行预处理;对搜索引擎数据集进行阶段性的数据维护;支持系统多分级管理系统,包括逐级进行初审功能;支持信息服务:最新报导、热点新闻、分类阅读、舆情简报、信息检索、RSS订阅等服务;信息文档转换技术:可以对信息进行传统文件格式转换。如:Doc、Excel、Access、Rss等文件生成。可生成报表。数安舆情监控系统先进技术网路信息采集技术)强大的信息采集功能全网全天候采集网络舆情,保障信息全面采集。)舆情源监控广泛对网络舆情主要来源进行监控,包括:()新闻类门户网站,如人民网、新浪网、雅虎()政府机构门户网站,如首都之窗、中国政府网()信息资讯网站,各地信息港、行业咨询网()交互性质网站,如峰会、BBS、百度贴吧()个人式媒体,博客)元数据搜索功能元搜索引擎集成了不同性能和不同风格的搜索引擎,并发展了一些新的查询功能。查一个元搜索引擎就相当于查多个独立搜索引擎。进行网路信息检索与搜集时,元搜。

6、行量身构建,建立适宜的舆情监控体系。第二章项目可行性剖析舆情剖析预警系统的实现具有可行性。一方面,舆情导向的预测不是一种具象的可能性,而是现实的可能性,这种现实可能性并非陡然想像而是有其现实基础,是对舆情的历史信息和其他诱因经过判定、分析而得出的推论。舆情也同其他事物一样,是一种客观存在,有其形成、发展、变化的规律。只要对其给以客观、全面、科学的考察,细致、认真、仔细地剖析,我们通过本系统对舆情导向的有无、好坏、大小,是可作出基本确切的评价和预测的。另一方面,我们通过数安舆情监控系统的搜索引擎、数据库房和数据挖掘等技术,为实现这一需求提供了有力的技术保障,使舆情剖析预警的实现具有了可能。价值剖析、帮助有针对性的搜集国家、地方和行业新政:帮助了解新政,有助于推进重大战略决策;、对网路危机风波产生快速反应机制:实时监控网民对各方面的关注意见,独特预警机制能初期发觉危机风波,及时预警并后期追踪,有利于把握危机事。

相似文档:

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看-高清在线阅读

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(网络分享版)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(全文完整版)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(图文高清版)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(手机版)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(范文1)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(模版2)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(样例3)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(资料4)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(备份存档)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(最终初稿)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(中文版)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(word版) 查看全部

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看

1、看,实现舆情剖析预警起码应包括:数据信息采集、统计挖掘预测、结果展示三个阶段。(如图)图舆情剖析预警系统系统结构数安舆情监控系统系统特性自定义URL来源及采集频率可以设定采集的栏目、URL、更新时间、扫描间隔等,系统的扫描间隔最小可以设置成分钟,即每隔一分钟,系统将手动扫描目标信息源,以便及时发觉目标信息源的最新变化,并以最快的速度采集到本地。支持多种网页格式可以采集常见的静态网页(HTMLHTMSHTML)和动态网页(ASPPHPJSP),还可以采集网页中收录的图片信息。支持多种字符集编码系采集子系统才能手动辨识多种字符集编码,包括英文、英文、中文繁体、中文简体等,并可以统一转换为GBK编码格式。支持整个互联网采集舆情检测系统搜索模式是以国外著名互联网搜索引擎的结果为基础并借助采集器直接面向互联网订制内容进行直接采集,只须要输入搜索关键词就可以了。支持内容抽取辨识系统可对网页进行内容剖析和过滤,自动清除。

2、索可指定搜索条件,既增强信息采集的针对性,又扩大采集范围的广度,收到事半功倍功效。)配置符合我公司需求的监控源方案系统为提供舆情源监控方案,对背景、行业、作者、正文等信息项,并对具有连续性内容的多个网页内容进行手动合并,论坛贴子主题、回帖、点击量等手动提取。)结构化采集技术数安舆情监控系统对网页数据进行结构化的信息抽取和数据储存,以满足多维度的信息挖掘和统计须要。)全天候不间断监控数安舆情监控系统*全天候监控互联网信息,也可设定采集时间;实施中可以做到分钟级的采集更新。)采集信息预处理数安舆情监控系统系统对采集信息进行系列预处理操作:超链剖析、编码辨识、URL去重、锚文本处理、垃圾信息过滤、关键字抽取、关键信息提取、正文抽取、自动摘要,达到系统舆情智能剖析前状态。数安舆情监控系统舆情智能剖析技术)自动分类技术手动分类技术包括以下两中分类方法:A基于内容的文本自动分类B基于规则的文本分类)自动聚类技术基于相。

3、件的破坏力和传播趋势,为危机公关服务。、了解在或潜在中的地位:帮助洞悉其、产品、品牌影响力,了解人们正反两方面的意见,客观评价其行业地位;、追踪上下游产品、新产品和新技术:帮助追踪上下游产品,有助于控制生产成本;追踪新产品新技术,有助于技术部门对产品线的技术革新;、服务于市场部门:快速对行情、促销、畅销区域、活动等作出反应,有助于市场部门做短期的营运规划;系统生成的统计报表,是对市场作出的一般性归纳,有利于市场部门做中常年的市场取舍。数安舆情监控系统三大模块舆情剖析引擎舆情剖析引擎为系统的核心功能,其主要包括以下功能:热点辨识能力、自动分类、聚类分析、倾向性剖析与统计、主题跟踪、信息手动摘要功能、截取证据、趋势剖析、突发事件剖析、报警系统、统计报告。互联网信息采集采用元搜索与信息雷达技术。智能信息抽取技术主要是针对特殊进行特定领域的信息采集。搜索引擎数据管理搜索引擎数据管理功能主要包括以下功能:对搜集到信。

4、似性算法的自动聚类技术,自动对海量的无规则文档进行归类,把内容相仿的文档归为一类,并手动为其生成主题词,为确定类目名称提供便捷。)相似性检索和查重技术基于文档“指纹”的文本查重技术,支持海量数据的信息查重。相似性检索是在文本集合中查找出与之内容相像的其他文本的技术。在实际应用中找出舆情信息内容雷同文章,对相像、雷同文章消重处理;还依据文章主题相似性,生成专题报导,背景剖析等。自然语言智能处理技术)自动分词技术以辞典为基础,规则与统计相结合的动词技术,有效解决切分歧义。综合运用基于机率统计的语言模型方式,分词准确性达到%。)自动关键词和手动摘要技术对采集到的网路信息,自动摘取相关关键字,并生成摘要,并与快速浏览与检索。全文检索技术全文检索将传统的全文检索技术与最新的WEB搜索技术相结合,大大提高检索引擎的性能指标。还融合多种技术,提供丰富的检索手段以及同义词等智能检索方法。第三章施行方案总体框架从整体结构上。

5、息进行预处理;对搜索引擎数据集进行阶段性的数据维护;支持系统多分级管理系统,包括逐级进行初审功能;支持信息服务:最新报导、热点新闻、分类阅读、舆情简报、信息检索、RSS订阅等服务;信息文档转换技术:可以对信息进行传统文件格式转换。如:Doc、Excel、Access、Rss等文件生成。可生成报表。数安舆情监控系统先进技术网路信息采集技术)强大的信息采集功能全网全天候采集网络舆情,保障信息全面采集。)舆情源监控广泛对网络舆情主要来源进行监控,包括:()新闻类门户网站,如人民网、新浪网、雅虎()政府机构门户网站,如首都之窗、中国政府网()信息资讯网站,各地信息港、行业咨询网()交互性质网站,如峰会、BBS、百度贴吧()个人式媒体,博客)元数据搜索功能元搜索引擎集成了不同性能和不同风格的搜索引擎,并发展了一些新的查询功能。查一个元搜索引擎就相当于查多个独立搜索引擎。进行网路信息检索与搜集时,元搜。

6、行量身构建,建立适宜的舆情监控体系。第二章项目可行性剖析舆情剖析预警系统的实现具有可行性。一方面,舆情导向的预测不是一种具象的可能性,而是现实的可能性,这种现实可能性并非陡然想像而是有其现实基础,是对舆情的历史信息和其他诱因经过判定、分析而得出的推论。舆情也同其他事物一样,是一种客观存在,有其形成、发展、变化的规律。只要对其给以客观、全面、科学的考察,细致、认真、仔细地剖析,我们通过本系统对舆情导向的有无、好坏、大小,是可作出基本确切的评价和预测的。另一方面,我们通过数安舆情监控系统的搜索引擎、数据库房和数据挖掘等技术,为实现这一需求提供了有力的技术保障,使舆情剖析预警的实现具有了可能。价值剖析、帮助有针对性的搜集国家、地方和行业新政:帮助了解新政,有助于推进重大战略决策;、对网路危机风波产生快速反应机制:实时监控网民对各方面的关注意见,独特预警机制能初期发觉危机风波,及时预警并后期追踪,有利于把握危机事。

相似文档:

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看-高清在线阅读

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(网络分享版)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(全文完整版)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(图文高清版)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(手机版)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(范文1)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(模版2)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(样例3)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(资料4)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(备份存档)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(最终初稿)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(中文版)

亲稳网络舆情监控系统项目投资可研报告全文免费阅读、在线看(word版)

BigData-‘基于代价优化’究竟是如何一回事?

采集交流 • 优采云 发表了文章 • 0 个评论 • 166 次浏览 • 2020-08-24 20:22

本文系转载,如有侵权,立删

还记得笔者在下篇文章无意中挖的一个坑么?如若不知,强烈建议看官先行阅读上面两文-《SparkSQL – 有必要坐出来说说Join》和《BigData – Join中居然也有子句下推!?》。第一篇文章主要剖析了大数据领域Join的三种基础算法以及各自的适用场景,第二篇文章在第一篇的基础上进一步深入,讨论了Join基础算法的一种优化方案 – Runtime Filter,文章最后还引申地聊了聊子句下推技术。同时,在第二篇文章开头,笔者引出了两个问题,SQL执行引擎怎么知晓参与Join的两波数据集大小?衡量两波数据集大小的是化学大小还是纪录多少甚或二者都有?这关系到SQL解析器怎样正确选择Join算法的问题。好了,这些就是这篇文章要为你们带来的议程-基于代价优化(Cost-Based Optimization,简称CBO)。

CBO基本原理

提到CBO,就不得不提起一位’老熟人’ – 基于规则优化(Rule-Based Optimization,简称RBO)。RBO是一种经验式、启发式的优化思路,优化规则都早已预先定义好,只须要将SQL往这种规则上套就可以(对RBO还不了解的童鞋,可以参考笔者的另一篇文章 – 《从0到1认识Catalyst》)。说白了,RBO如同是一个经验丰富的老司机,基本套路全都晓得。

然而世界上有一种东西称作 – 不按套路来,与其说它不按套路来,倒不如说它本身并没有哪些套路。最典型的莫过于复杂Join算子优化,对于那些Join来说,通常有两个选择题要做:

1. Join应当选择哪种算法策略来执行?BroadcastJoin or ShuffleHashJoin or SortMergeJoin?不同的执行策略对系统的资源要求不同,执行效率也有天壤之别,同一个SQL,选择到合适的策略执行可能只须要几秒钟,而假如没有选择到合适的执行策略就可能会造成系统OOM。

2. 对于雪花模型或则星型模型来讲,多表Join应当选择什么样的次序执行?不同的Join次序意味着不同的执行效率,比如A join B join C,A、B表都很大,C表太小,那A join B很显然须要大量的系统资源来运算,执行时间必然不会短。而假如使用A join C join B的执行次序,因为C表太小,所以A join C会很快得到结果,而且结果游行太小,再使用小的结果集 join B,性能显而易见会好于前一种方案。

大家想想,这有哪些固定的优化规则么?并没有。说白了,你须要晓得更多关于表的基础信息(表大小、表记录总条数等),再通过一定规则代价评估能够从中选择一条最优的执行计划。CBO意为基于代价优化策略,就是从多个可能的语法树中选择一条代价最小的语法树来执行,换个说法,CBO的核心在于评估出一条给定语法树的实际代价。比如下边这颗SQL语法树:

要评估给定整棵树的代价,分而治之只须要评估每位节点执行的代价,最后将所有节点代价累加即可。而要评估单个节点执行实际代价,又须要晓得两点,其一是这些算子的代价规则,每种算子的代价估算规则必然都不同,比如Merge-Sort Join、Shuffle Hash Join、GroupBy都有自己的一套代价估算算法。其二是参与操作的数据集基本信息(大小、总记录条数),比如实际参与Merge-Sort Join的两表大小,作为节点实际执行代价的一个重要诱因,当然特别重要。试想,同样是Table Scan操作,大表和小表的执行代价必然不同。

为给定算子的代价进行评估说究竟也是一种算法,算法都是死的,暂且不表,下文简述。而参与的数据集基本信息却是活的,为什么这么说,因为这种数据集都是原创表经过过滤、聚合以后的中间结果,没有规则直接告诉你这个中间结果有多少数据!那中间结果的基本信息怎样评估呢?推导!对,原创表基本信息我们是可以晓得的,如果能够一层一层向下推论,是不是就有可能晓得所求中间结果信息!

这里又将任意节点中间结果信息评估分拆为两个子问题:首先评估叶子节点(原创表)的基本信息,其次一层一层往上推论。评估原创表基本信息想想总是有办法的,粗暴点就全表扫描,获取记录条数、最大值、最小值,总之是可以做到的。那基本信息怎样一层一层往上推论呢?规则!比如原创表经过 id = 12这个Filter过滤以后的数据集信息(数据集大小等)就可以经过一定的规则推论下来,不同算子有不同的规则,下文阐述!

好吧,上文耗费了大量时间将一个完整的CBO解剖的零零碎碎,变成了一堆规则加原创表的扫描。相信你们都有点懵懵的。莫慌,我们再来理一遍:

1. 基于代价优化(CBO)原理是估算所有执行路径的代价,并选购代价最小的执行路径。问题转化为:如何估算一条给定执行路径的代价

2. 计算给定路径的执行代价,只须要估算这条路径上每位节点的执行代价,最后相乘即可。问题转化为:如何估算其中任意一个节点的执行代价

3. 计算任意节点的执行代价,只须要晓得当前节点算子的代价估算规则以及参与估算的数据集(中间结果)基本信息(数据量大小、数据条数等)。问题转化为:如何估算中间结果的基本信息以及定义算子代价估算规则

4. 算子代价估算规则是一种死的规则,可定义。而任意中间结果基本信息须要通过原创表基本信息沿着语法树一层一层往上推论得出。问题转化为:如何估算原创表基本信息以及定义推论规则

很显然,上述过程是思维过程,真正工程实践是反着由下往上一步一步执行,最终得到代价最小的执行路径。现在再把它从一个个零件组装上去:

1. 首先采集原创表基本信息

2. 再定义每种算子的基数评估规则,即一个数据集经过此算子执行以后基本信息变化规则。这两步完成以后就可以推论出整个执行计划树上所有中间结果集的数据基本信息

3. 定义每种算子的执行代价,结合中间结果集的基本信息,此时可以得出任意节点的执行代价

4. 将给定执行路径上所有算子的代价累加得到整棵语法树的代价

5. 计算出所有可能语法树代价,并选出一条代价最小的

CBO基本实现思路

上文从理论层面剖析了CBO的实现思路,将完整的CBO功能分拆为了多个子功能,接下来谈谈对每一个子功能的实现。

第一步:采集参原创表基本信息

这个操作是CBO最基础的一项工作,采集的主要信息包括表级别指标和列级别指标,如下所示,estimatedSize和rowCount为表级别信息,basicStats和Histograms为列级别信息,后者细度更细,对优化愈发重要。

这里有两个问题值得思索:

1. 为什么要采集这些信息?每个对象在优化过程中起到哪些作用?

2. 实际工程通常是怎样实现这种数据采集的?

为什么要采集这些信息?很显然,estimatedSize和rowCount这两个值是算子代价评估的直观彰显,这两个值越大,给定算子执行代价必然越大,所以这两个值后续会拿来评估实际算子的执行代价。那basicStats和Histograms这俩拿来干啥呢,要不忘初心,之所以采集原创表的这种信息,是为了沿着执行语法树往上一层一层推论出所有中间结果的基本信息,这俩就是来干这个的,至于如何实现的,下一小节会举个事例解释。

实际工程怎么实现这种数据采集?一般有两种比较可行的方案:打开所有表扫描一遍,这样最简单,而且统计信息确切,缺点是对于大表来说代价比较大;针对一些大表,扫描一遍代价很大,可以采用取样(sample)的形式统计估算。

支持CBO的系统都有命令对原创数据信息进行统计,比如Hive的Analyze命令、Impala的Compute命令、Greenplum的Analyze命令等,但是须要注意那些命令并不是随时都应当执行的,首先在表数据没有大变动的情况下没必要执行,其次在系统查询高发期也不应当执行。这里有个最佳实践:尽可能在业务低峰期对表数据有较大变动的表单独执行统计命令,这句话有三个重点,不知道你看下来没有?

第二步:定义核心算子的基数推论规则

规则推论意思是说在当前子节点统计信息的基础上,计算父节点相关统计信息的一套推论规则。对于不同算子,推导规则必然不一样,比如fliter、group by、limit等等的评估推论是不同的。这里以filter为例进行讲解。先来瞧瞧这样一个SQL:select * from A , C where A.id = C.c_id and C.c_id > N,经过RBO以后的语法树如下图所示:

问题定义为:假如如今早已晓得表C的基本统计信息(estimatedSize、rowCount、basicStats以及histograms),如何推论出经过C.c_id > N过滤后中间结果的基本统计信息。我们来瞧瞧:

1. 假设已知C列的最小值c_id.Min、最大值c_id.Max以及总行数c_id.Distinct,同时假定数据分布均匀,如下图所示:

2. 现在分别有三种情况须要说明,其一是N大于c_id.Min,其二是N小于c_id.Max,其三是N介于c_id.Min和c_id.Max之间。前两种场景是第三种场景的特殊情况,这里简单的针对第三种场景说明。如下图所示:

在C.c_id > N过滤条件下,c_id.Min会减小到N,c_id.Max保持不变。而过滤后总行数c_id.distinct(after filter) = (c_id.Max – N) / (c_id.Max – c_id.Min) * c_id.distinct(before filter)

简单吧,但是注意哈,上面估算是在假定数据分布均匀的前提下完成的,而实际场景中数据分布很显然不可能均衡。数据分布一般成机率分布,histograms在这里就要登场了,说白了它就是一个柱状分布图,如下图:

柱状图横座标表示列值大小分布,纵座标表示频度。假设N在如图所示位置,那过滤后总行数c_id.distinct(after filter) = height(>N) / height(All) * c_id.distinct(before filter)

当然,上述所有估算都只是示意性估算,真实算法会复杂好多。另外,如果你们对group by 、limit等子句的评估规则比较感兴趣的话,可以阅读SparkSQL CBO设计文档,在此不再赘言。至此,通过各类评估规则以及原创表统计信息就可以估算出语法树中所有中间节点的基本统计信息了,这是万里长征的第二步,也是至关重要的一步。接下来继续往前走,看看怎样估算每种核心算子的实际代价。

第三步:核心算子实际代价估算

打文章一开始就开口闭口代价代价的,可究竟哪些是代价,怎么定义代价?这么说吧,每个系统对代价的定义并不十分一致,有的由于实现的诱因设置的比较简单,有的会比较复杂。这一节主要来简单说说每位节点的执行代价,上文说了,一条执行路径的总代价就是这条路径上所有节点的代价累加之和。

通常来讲,节点实际执行代价主要从两个维度来定义:CPU Cost以及IO Cost。为后续讲解便捷起见,需要先行定义一些基本参数:

Table Scan算子

Scan算子通常坐落语法树的叶子结点,直观上来讲这类算子只有IO Cost,CPU Cost为0。Table Scan Cost = IO Cost = Tr * Tsz * Hr,很简单,Tr * Tsz表示须要scan的数据总大小,再减去Hr就是所需代价。OK,很直观,很简单。

Hash Join算子

以Broadcast Hash Join为例(如果看官对Broadcast Hash Join工作原理还不了解,可戳这儿),假设大表分布在n个节点上,每个节点的数据条数\平均大小分别为Tr(R1)\Tsz(R1),Tr(R2)\Tsz(R2), … Tr(Rn)\Tsz(Rn),小表数据条数为Tr(Rsmall)\Tsz(Rsmall),那么CPU代价和IO代价分别为:

CPU Cost = 小表建立Hash Table代价 + 大表侦测代价 = Tr(Rsmall) * CPUc + (Tr(R1) + Tr(R2) + … + Tr(Rn)) * N * CPUc,此处假定HashTable建立所需CPU资源远远低于两值简单比较代价,为N * CPUc

IO Cost = 小表scan代价 + 小表广播代价 + 大表scan代价 = Tr(Rsmall) * Tsz(Rsmall) * Hr + n * Tr(Rsmall) * Tsz(Rsmall) * NEt + (Tr(R1)* Tsz(R1) + … + Tr(Rn) * Tsz(Rn)) * Hr

很显然,Hash Join算子相比Table Scan算子来讲稍微复杂了一点,但是无论哪种算子,代价估算都和参与的数据总条数、数据平均大小等诱因直接相关,这也就是为何在之前两个步骤中要不懈余力地估算中间结果相关详尽的真正缘由。可谓是步步为营、环环相扣。这下好了,任意节点的实际代价都能评估下来,那么给定任意执行路径的代价必然也就很简单喽。

第四步:选择最优执行路径(代价最小执行路径)

这个思路很容易理解的,经过上述三步的努力,可以很容易地估算出任意一条给定路径的代价。那么你只须要找出所有可行的执行路径,一个一个估算,就必然能找到一个代价最小的,也就是最优的执行路径。

这条路看起来确实很简单,但实际做上去却并不这么容易,为什么?所有可行的执行路径实在太多,所有路径都估算一遍,黄花菜都凉了。那么有哪些好的解决方案么?当然,其实听到这个标题-选择代价最小执行路径,就应当很容易想到-动态规划,如果你没有想到,那只能说明你没有读过《数学之美》、没刷过LeetCode、没玩过ACM,ACM、LeetCode假如认为很沉闷,那就去瞧瞧《数学之美》,它会告诉你从当前这个你所在的地方驾车去上海,如何使用动态规划选择一条最短的路线。在此不再赘言。

至此,笔者粗线条地介绍了当前主流SQL引擎是怎样将CBO如此一个看似深奥的技术一步一步落地的。接下来,笔者将会借用Hive、Impala这两大SQL引擎开启CBO以后的优化疗效使你们对CBO有一个更直观的理解。

Hive – CBO优化疗效

Hive本身没有去从头实现一个SQL优化器,而是借助于Apache Calcite,Calcite是一个开源的、基于CBO的企业级SQL查询优化框架,目前包括Hive、Phoniex、Kylin以及Flink等项目都使用了Calcite作为其执行优化器,这也挺好理解,执行优化器原本就可以具象成一个系统模块,并没有必要耗费大量时间去重复造轮子。

hortonworks以前对Hive的CBO特点做了相关的测试,测试结果觉得CBO起码对查询有三个重要的影响:Join ordering optimization、Bushy join support以及Join simplification,本文只简单介绍一下Join ordering optimization,有兴趣的朋友可以继续阅读这篇文章来更多地了解其他两个重要影响。(下面数据以及示意图也来自于该篇文章,特此标明)

hortonworks对TPCDS的部份Query进行了研究,发现对于大部分星型\雪花模型,都存在多Join问题,这些Join次序假如组织不好,性能还会太差,如果组织得当,性能还会挺好。比如Query Q3:

select

dt.d_year,

item.i_brand_id brand_id,

item.i_brand brand,

sum(ss_ext_sales_price) sum_agg

from

date_dim dt,

store_sales,

item

where

dt.d_date_sk = store_sales.ss_sold_date_sk

and store_sales.ss_item_sk = item.i_item_sk

and item.i_manufact_id =436

and dt.d_moy =12

groupby dt.d_year , item.i_brand , item.i_brand_id

order by dt.d_year , sum_agg desc , brand_id

limit 10

上述Query涉及到3张表,一张事实表store_sales(数据量大)和两张维度表(数据量小),三表之间的关系如下图所示:

这里就涉及上文提及的Join次序问题,从原创表来看,date_dim有73049条记录,而item有462000条记录。很显然,如果没有其他暗示的话,Join次序必然是store_sales join date_dim join item。但是,where条件中还带有两个条件,CBO会依照过滤条件对过滤后的数据进行评估,结果如下:

Table

Cardinality

Cardinality after filter

Selectivity

date_dim

73,049

6200

8.5%

item

462,000

484

0.1%

根据上表所示,过滤后的数据量item显著比date_dim小的多,剧情反转的有点快。于是乎,经过CBO以后Join次序就弄成了store_sales join item join date_time,为了进一步确认,可以在开启CBO前后分别记录该SQL的执行计划,如下图所示:

左图是未开启CBO特点时Q3的执行计划,store_sales先与date_dim进行join,join后的中间结果数据集有140亿条。而再看下图,store_sales先于item进行join,中间结果只有8200w条。很显然,后者执行效率会更高,实践出真知,来瞧瞧二者的实际执行时间:

Test

Query Response Time(seconds)

Intermediate Rows

CPU(seconds)

Q3 CBO OFF

255

13,987,506,884

51,967

Q3 CBO ON

142

86,217,653

35,036

上图很明显的看出Q3在CBO的优化下性能将近提高了1倍,与此同时,CPU资源使用率也减少了一半左右。不得不说,TPCDS中有好多相像的Query,有兴趣的朋友可以深入进一步深入了解。

Impala – CBO优化疗效

和Hive优化的原理相同,也是针对复杂join的执行次序、Join的执行策略选择优化等方面进行的优化,本人使用TPC-DS对Impala在开启CBO特点前后的部份Query进行了性能测试,测试结果如下图所示:

CBO总结

这篇文章其实很早就开始构思了,前前后后花了将近3个月时间断断续续来写,写了删、删了写,记得第二稿早已写了好多内容,有天一大早睡醒完完整整地看了一遍,发现写的东西并不是自己想要的,准确说,写的缺乏这么一些些条理智,改又不好改,索性就全删了。另一方面,也有由于当前网路上并没有太多关于CBO的完整介绍,倒是找到一些中文资料,但总觉得还是缺少条理性,很难理解。本文第一节重点从思维上带你们认识CBO,第二节更多的从实现的视角一步一步将整个原理粗线条地落地,第三节选购Hive与Impala两款产品对比介绍开启CBO以后的优化疗效,使你们有一个更直观的体味。

好了,关于Join这个话题,洋洋洒洒前前后后写了三篇文章,能看到这儿的只能说是真爱!说实话,笔者并没有完整的看过RuntimeFilter的代码实现,也没有系统地学过任何一套CBO的代码实现,所写内容大体来自于三个方面:官方博客文档、分析理解、撸起衣袖实践。所以看官可要批判性地去阅读,有错误的地方在所难免,希望还能多多交流见谅。后期笔者一定会阅读相关的代码实现,有新的发觉再和你们一起分享~

参考资料

1. Enhancements on Spark SQL optimizer :

2. Impala Table and Column Statistics :

3. Enhancing Spark SQL Optimizer with Reliable Statistics :

4. Cost-based Optimizer framework :

5.

6.

本文系转载,如有侵权,立删

原文链接:%EF%BC%8Dcbo/?lovyta=rrfzx3 查看全部

BigData-‘基于代价优化’究竟是如何一回事?

本文系转载,如有侵权,立删

还记得笔者在下篇文章无意中挖的一个坑么?如若不知,强烈建议看官先行阅读上面两文-《SparkSQL – 有必要坐出来说说Join》和《BigData – Join中居然也有子句下推!?》。第一篇文章主要剖析了大数据领域Join的三种基础算法以及各自的适用场景,第二篇文章在第一篇的基础上进一步深入,讨论了Join基础算法的一种优化方案 – Runtime Filter,文章最后还引申地聊了聊子句下推技术。同时,在第二篇文章开头,笔者引出了两个问题,SQL执行引擎怎么知晓参与Join的两波数据集大小?衡量两波数据集大小的是化学大小还是纪录多少甚或二者都有?这关系到SQL解析器怎样正确选择Join算法的问题。好了,这些就是这篇文章要为你们带来的议程-基于代价优化(Cost-Based Optimization,简称CBO)。

CBO基本原理

提到CBO,就不得不提起一位’老熟人’ – 基于规则优化(Rule-Based Optimization,简称RBO)。RBO是一种经验式、启发式的优化思路,优化规则都早已预先定义好,只须要将SQL往这种规则上套就可以(对RBO还不了解的童鞋,可以参考笔者的另一篇文章 – 《从0到1认识Catalyst》)。说白了,RBO如同是一个经验丰富的老司机,基本套路全都晓得。

然而世界上有一种东西称作 – 不按套路来,与其说它不按套路来,倒不如说它本身并没有哪些套路。最典型的莫过于复杂Join算子优化,对于那些Join来说,通常有两个选择题要做:

1. Join应当选择哪种算法策略来执行?BroadcastJoin or ShuffleHashJoin or SortMergeJoin?不同的执行策略对系统的资源要求不同,执行效率也有天壤之别,同一个SQL,选择到合适的策略执行可能只须要几秒钟,而假如没有选择到合适的执行策略就可能会造成系统OOM。

2. 对于雪花模型或则星型模型来讲,多表Join应当选择什么样的次序执行?不同的Join次序意味着不同的执行效率,比如A join B join C,A、B表都很大,C表太小,那A join B很显然须要大量的系统资源来运算,执行时间必然不会短。而假如使用A join C join B的执行次序,因为C表太小,所以A join C会很快得到结果,而且结果游行太小,再使用小的结果集 join B,性能显而易见会好于前一种方案。

大家想想,这有哪些固定的优化规则么?并没有。说白了,你须要晓得更多关于表的基础信息(表大小、表记录总条数等),再通过一定规则代价评估能够从中选择一条最优的执行计划。CBO意为基于代价优化策略,就是从多个可能的语法树中选择一条代价最小的语法树来执行,换个说法,CBO的核心在于评估出一条给定语法树的实际代价。比如下边这颗SQL语法树:

要评估给定整棵树的代价,分而治之只须要评估每位节点执行的代价,最后将所有节点代价累加即可。而要评估单个节点执行实际代价,又须要晓得两点,其一是这些算子的代价规则,每种算子的代价估算规则必然都不同,比如Merge-Sort Join、Shuffle Hash Join、GroupBy都有自己的一套代价估算算法。其二是参与操作的数据集基本信息(大小、总记录条数),比如实际参与Merge-Sort Join的两表大小,作为节点实际执行代价的一个重要诱因,当然特别重要。试想,同样是Table Scan操作,大表和小表的执行代价必然不同。

为给定算子的代价进行评估说究竟也是一种算法,算法都是死的,暂且不表,下文简述。而参与的数据集基本信息却是活的,为什么这么说,因为这种数据集都是原创表经过过滤、聚合以后的中间结果,没有规则直接告诉你这个中间结果有多少数据!那中间结果的基本信息怎样评估呢?推导!对,原创表基本信息我们是可以晓得的,如果能够一层一层向下推论,是不是就有可能晓得所求中间结果信息!

这里又将任意节点中间结果信息评估分拆为两个子问题:首先评估叶子节点(原创表)的基本信息,其次一层一层往上推论。评估原创表基本信息想想总是有办法的,粗暴点就全表扫描,获取记录条数、最大值、最小值,总之是可以做到的。那基本信息怎样一层一层往上推论呢?规则!比如原创表经过 id = 12这个Filter过滤以后的数据集信息(数据集大小等)就可以经过一定的规则推论下来,不同算子有不同的规则,下文阐述!

好吧,上文耗费了大量时间将一个完整的CBO解剖的零零碎碎,变成了一堆规则加原创表的扫描。相信你们都有点懵懵的。莫慌,我们再来理一遍:

1. 基于代价优化(CBO)原理是估算所有执行路径的代价,并选购代价最小的执行路径。问题转化为:如何估算一条给定执行路径的代价

2. 计算给定路径的执行代价,只须要估算这条路径上每位节点的执行代价,最后相乘即可。问题转化为:如何估算其中任意一个节点的执行代价

3. 计算任意节点的执行代价,只须要晓得当前节点算子的代价估算规则以及参与估算的数据集(中间结果)基本信息(数据量大小、数据条数等)。问题转化为:如何估算中间结果的基本信息以及定义算子代价估算规则

4. 算子代价估算规则是一种死的规则,可定义。而任意中间结果基本信息须要通过原创表基本信息沿着语法树一层一层往上推论得出。问题转化为:如何估算原创表基本信息以及定义推论规则

很显然,上述过程是思维过程,真正工程实践是反着由下往上一步一步执行,最终得到代价最小的执行路径。现在再把它从一个个零件组装上去:

1. 首先采集原创表基本信息

2. 再定义每种算子的基数评估规则,即一个数据集经过此算子执行以后基本信息变化规则。这两步完成以后就可以推论出整个执行计划树上所有中间结果集的数据基本信息

3. 定义每种算子的执行代价,结合中间结果集的基本信息,此时可以得出任意节点的执行代价

4. 将给定执行路径上所有算子的代价累加得到整棵语法树的代价

5. 计算出所有可能语法树代价,并选出一条代价最小的

CBO基本实现思路

上文从理论层面剖析了CBO的实现思路,将完整的CBO功能分拆为了多个子功能,接下来谈谈对每一个子功能的实现。

第一步:采集参原创表基本信息

这个操作是CBO最基础的一项工作,采集的主要信息包括表级别指标和列级别指标,如下所示,estimatedSize和rowCount为表级别信息,basicStats和Histograms为列级别信息,后者细度更细,对优化愈发重要。

这里有两个问题值得思索:

1. 为什么要采集这些信息?每个对象在优化过程中起到哪些作用?

2. 实际工程通常是怎样实现这种数据采集的?

为什么要采集这些信息?很显然,estimatedSize和rowCount这两个值是算子代价评估的直观彰显,这两个值越大,给定算子执行代价必然越大,所以这两个值后续会拿来评估实际算子的执行代价。那basicStats和Histograms这俩拿来干啥呢,要不忘初心,之所以采集原创表的这种信息,是为了沿着执行语法树往上一层一层推论出所有中间结果的基本信息,这俩就是来干这个的,至于如何实现的,下一小节会举个事例解释。

实际工程怎么实现这种数据采集?一般有两种比较可行的方案:打开所有表扫描一遍,这样最简单,而且统计信息确切,缺点是对于大表来说代价比较大;针对一些大表,扫描一遍代价很大,可以采用取样(sample)的形式统计估算。

支持CBO的系统都有命令对原创数据信息进行统计,比如Hive的Analyze命令、Impala的Compute命令、Greenplum的Analyze命令等,但是须要注意那些命令并不是随时都应当执行的,首先在表数据没有大变动的情况下没必要执行,其次在系统查询高发期也不应当执行。这里有个最佳实践:尽可能在业务低峰期对表数据有较大变动的表单独执行统计命令,这句话有三个重点,不知道你看下来没有?

第二步:定义核心算子的基数推论规则

规则推论意思是说在当前子节点统计信息的基础上,计算父节点相关统计信息的一套推论规则。对于不同算子,推导规则必然不一样,比如fliter、group by、limit等等的评估推论是不同的。这里以filter为例进行讲解。先来瞧瞧这样一个SQL:select * from A , C where A.id = C.c_id and C.c_id > N,经过RBO以后的语法树如下图所示:

问题定义为:假如如今早已晓得表C的基本统计信息(estimatedSize、rowCount、basicStats以及histograms),如何推论出经过C.c_id > N过滤后中间结果的基本统计信息。我们来瞧瞧:

1. 假设已知C列的最小值c_id.Min、最大值c_id.Max以及总行数c_id.Distinct,同时假定数据分布均匀,如下图所示:

2. 现在分别有三种情况须要说明,其一是N大于c_id.Min,其二是N小于c_id.Max,其三是N介于c_id.Min和c_id.Max之间。前两种场景是第三种场景的特殊情况,这里简单的针对第三种场景说明。如下图所示:

在C.c_id > N过滤条件下,c_id.Min会减小到N,c_id.Max保持不变。而过滤后总行数c_id.distinct(after filter) = (c_id.Max – N) / (c_id.Max – c_id.Min) * c_id.distinct(before filter)

简单吧,但是注意哈,上面估算是在假定数据分布均匀的前提下完成的,而实际场景中数据分布很显然不可能均衡。数据分布一般成机率分布,histograms在这里就要登场了,说白了它就是一个柱状分布图,如下图:

柱状图横座标表示列值大小分布,纵座标表示频度。假设N在如图所示位置,那过滤后总行数c_id.distinct(after filter) = height(>N) / height(All) * c_id.distinct(before filter)

当然,上述所有估算都只是示意性估算,真实算法会复杂好多。另外,如果你们对group by 、limit等子句的评估规则比较感兴趣的话,可以阅读SparkSQL CBO设计文档,在此不再赘言。至此,通过各类评估规则以及原创表统计信息就可以估算出语法树中所有中间节点的基本统计信息了,这是万里长征的第二步,也是至关重要的一步。接下来继续往前走,看看怎样估算每种核心算子的实际代价。

第三步:核心算子实际代价估算

打文章一开始就开口闭口代价代价的,可究竟哪些是代价,怎么定义代价?这么说吧,每个系统对代价的定义并不十分一致,有的由于实现的诱因设置的比较简单,有的会比较复杂。这一节主要来简单说说每位节点的执行代价,上文说了,一条执行路径的总代价就是这条路径上所有节点的代价累加之和。

通常来讲,节点实际执行代价主要从两个维度来定义:CPU Cost以及IO Cost。为后续讲解便捷起见,需要先行定义一些基本参数:

Table Scan算子

Scan算子通常坐落语法树的叶子结点,直观上来讲这类算子只有IO Cost,CPU Cost为0。Table Scan Cost = IO Cost = Tr * Tsz * Hr,很简单,Tr * Tsz表示须要scan的数据总大小,再减去Hr就是所需代价。OK,很直观,很简单。

Hash Join算子

以Broadcast Hash Join为例(如果看官对Broadcast Hash Join工作原理还不了解,可戳这儿),假设大表分布在n个节点上,每个节点的数据条数\平均大小分别为Tr(R1)\Tsz(R1),Tr(R2)\Tsz(R2), … Tr(Rn)\Tsz(Rn),小表数据条数为Tr(Rsmall)\Tsz(Rsmall),那么CPU代价和IO代价分别为:

CPU Cost = 小表建立Hash Table代价 + 大表侦测代价 = Tr(Rsmall) * CPUc + (Tr(R1) + Tr(R2) + … + Tr(Rn)) * N * CPUc,此处假定HashTable建立所需CPU资源远远低于两值简单比较代价,为N * CPUc

IO Cost = 小表scan代价 + 小表广播代价 + 大表scan代价 = Tr(Rsmall) * Tsz(Rsmall) * Hr + n * Tr(Rsmall) * Tsz(Rsmall) * NEt + (Tr(R1)* Tsz(R1) + … + Tr(Rn) * Tsz(Rn)) * Hr

很显然,Hash Join算子相比Table Scan算子来讲稍微复杂了一点,但是无论哪种算子,代价估算都和参与的数据总条数、数据平均大小等诱因直接相关,这也就是为何在之前两个步骤中要不懈余力地估算中间结果相关详尽的真正缘由。可谓是步步为营、环环相扣。这下好了,任意节点的实际代价都能评估下来,那么给定任意执行路径的代价必然也就很简单喽。

第四步:选择最优执行路径(代价最小执行路径)

这个思路很容易理解的,经过上述三步的努力,可以很容易地估算出任意一条给定路径的代价。那么你只须要找出所有可行的执行路径,一个一个估算,就必然能找到一个代价最小的,也就是最优的执行路径。

这条路看起来确实很简单,但实际做上去却并不这么容易,为什么?所有可行的执行路径实在太多,所有路径都估算一遍,黄花菜都凉了。那么有哪些好的解决方案么?当然,其实听到这个标题-选择代价最小执行路径,就应当很容易想到-动态规划,如果你没有想到,那只能说明你没有读过《数学之美》、没刷过LeetCode、没玩过ACM,ACM、LeetCode假如认为很沉闷,那就去瞧瞧《数学之美》,它会告诉你从当前这个你所在的地方驾车去上海,如何使用动态规划选择一条最短的路线。在此不再赘言。

至此,笔者粗线条地介绍了当前主流SQL引擎是怎样将CBO如此一个看似深奥的技术一步一步落地的。接下来,笔者将会借用Hive、Impala这两大SQL引擎开启CBO以后的优化疗效使你们对CBO有一个更直观的理解。

Hive – CBO优化疗效

Hive本身没有去从头实现一个SQL优化器,而是借助于Apache Calcite,Calcite是一个开源的、基于CBO的企业级SQL查询优化框架,目前包括Hive、Phoniex、Kylin以及Flink等项目都使用了Calcite作为其执行优化器,这也挺好理解,执行优化器原本就可以具象成一个系统模块,并没有必要耗费大量时间去重复造轮子。