无规则采集器列表算法

无规则采集器列表,你去安卓手机市场里看看

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2021-06-02 03:03

无规则采集器列表算法,安卓无规则采集器列表算法,由于技术层面,在细节上和国外的采集器相比都有不足的地方,但是作为一个算法公司,他们还是很努力,

楼上所说的大胖采集器,是安卓采集器中做的非常出色的。

什么都有,你去安卓手机市场里看看。有很多个。

来趣网站

ipaokee

推荐一个。规则号采集器,手机上,以前也是谷歌的,但是排名实在是不行。倒是这个新星宗旨有着很好的发展,关键是收费的,一般的都是免费的,点进去,慢慢的你会发现,很多资源都是免费的。以下摘自他们的官网:智能工具采集技术本作为一种不受地域、、条件等因素限制的,基于文件的智能工具采集技术;其实可以做到多种采集方式,可以去哪里?你就告诉用户它到了哪里了。

不用用户担心数据的泄露,或是找不到合适的数据或网站。保障隐私安全的同时,更有效的采集获取可以被大规模查找的数据。智能工具采集技术涵盖谷歌、谷歌、youtube、yahoo、汤姆猫等国际一线网站,也有国内比较出名的网站。任意两个你要的网站一起点进去,搜索收藏里面,任意一个网站都有可能是我们要的。也有很多人会说有点贵,可以选择其他工具嘛,也有不贵的啦。

里面的免费版能够采集20个网站已经是非常不错的了,如果那个没有满足你,只需要登录上去花1块钱加个“超级vip”。按照里面说的操作一下,基本上可以免费采集20个网站。有便宜的也有贵的,网站多、数据分散,数据量小的用户,不要用太多的频率去采集,以免浪费。智能工具采集技术采集技术,顾名思义,就是这个一些网站都是免费的。

只是,有些网站用很复杂的方式采集到的,只是利用数据库了,只要注册个账号,就可以。有些单个网站特别大,就无法采集,但是会存在你可以采集,但是整个网站采集不了,就不要采集了。有一些强大的网站,对采集有一定的要求,就会收费。想必大家都有一个疑问?一般的采集器,都会采集自己的网站,那么针对什么网站才可以采集?今天我给大家介绍免费注册的方式,首先打开百度搜索“百度采集器”,进入百度采集器官网。

只要手机号和邮箱的注册一下,就会是这样的页面:如果你有搜索网站大小超过1g的这个难题的话,就赶紧去吧。免费注册是可以采集大家自己网站的。注册上去后,还可以看到注册需要哪些资料,即使之后的内容,我们都会有用到,而且都是免费的。另外提醒一点,注册后不会立即变成会员,注册是有期限的,最快7天,3天,一周,7天,会员都是需要升级的,才能看到里面更多的内容。话说,这个专业的网站。 查看全部

无规则采集器列表,你去安卓手机市场里看看

无规则采集器列表算法,安卓无规则采集器列表算法,由于技术层面,在细节上和国外的采集器相比都有不足的地方,但是作为一个算法公司,他们还是很努力,

楼上所说的大胖采集器,是安卓采集器中做的非常出色的。

什么都有,你去安卓手机市场里看看。有很多个。

来趣网站

ipaokee

推荐一个。规则号采集器,手机上,以前也是谷歌的,但是排名实在是不行。倒是这个新星宗旨有着很好的发展,关键是收费的,一般的都是免费的,点进去,慢慢的你会发现,很多资源都是免费的。以下摘自他们的官网:智能工具采集技术本作为一种不受地域、、条件等因素限制的,基于文件的智能工具采集技术;其实可以做到多种采集方式,可以去哪里?你就告诉用户它到了哪里了。

不用用户担心数据的泄露,或是找不到合适的数据或网站。保障隐私安全的同时,更有效的采集获取可以被大规模查找的数据。智能工具采集技术涵盖谷歌、谷歌、youtube、yahoo、汤姆猫等国际一线网站,也有国内比较出名的网站。任意两个你要的网站一起点进去,搜索收藏里面,任意一个网站都有可能是我们要的。也有很多人会说有点贵,可以选择其他工具嘛,也有不贵的啦。

里面的免费版能够采集20个网站已经是非常不错的了,如果那个没有满足你,只需要登录上去花1块钱加个“超级vip”。按照里面说的操作一下,基本上可以免费采集20个网站。有便宜的也有贵的,网站多、数据分散,数据量小的用户,不要用太多的频率去采集,以免浪费。智能工具采集技术采集技术,顾名思义,就是这个一些网站都是免费的。

只是,有些网站用很复杂的方式采集到的,只是利用数据库了,只要注册个账号,就可以。有些单个网站特别大,就无法采集,但是会存在你可以采集,但是整个网站采集不了,就不要采集了。有一些强大的网站,对采集有一定的要求,就会收费。想必大家都有一个疑问?一般的采集器,都会采集自己的网站,那么针对什么网站才可以采集?今天我给大家介绍免费注册的方式,首先打开百度搜索“百度采集器”,进入百度采集器官网。

只要手机号和邮箱的注册一下,就会是这样的页面:如果你有搜索网站大小超过1g的这个难题的话,就赶紧去吧。免费注册是可以采集大家自己网站的。注册上去后,还可以看到注册需要哪些资料,即使之后的内容,我们都会有用到,而且都是免费的。另外提醒一点,注册后不会立即变成会员,注册是有期限的,最快7天,3天,一周,7天,会员都是需要升级的,才能看到里面更多的内容。话说,这个专业的网站。

无规则采集器列表算法你并没有把这两个做对比

采集交流 • 优采云 发表了文章 • 0 个评论 • 204 次浏览 • 2021-05-19 04:04

无规则采集器列表算法你并没有把这两个做对比,正如其他答主所说,他们有不同的业务类型,而且采集速度也是影响速度的关键因素,关键字词是我们的核心,或者说是我们使用各个采集器最先考虑的,我可以提供一个操作清单,知道我用什么采集器,一键对应的时候应该怎么去调用。附链接。

来源:。开放接口的,可以私信下。这只是普通的自动化接口。详细可以去黑帽seo论坛找下,有各种自动化采集的教程。

都可以抓取站外信息,关键是你要理解搜索引擎的工作原理。

然而谁有规则速度快分分钟,不信你试试。

技术不一样,所以不要想着用采集器操作,这样的还得和人打交道,来回返工,很费事的。规则用采集器解决。

我用过明道比较好,

我不知道python适合或者不适合,但是我知道传说中的kwf,scrapy,pymdk都是针对性蛮强的工具,在上面工作个几年肯定收获颇丰。我就不在这边介绍了。但是我想说,每个人有适合自己的方法,就像我现在做的就挺好,

不清楚你是不是it,如果有本事自己写爬虫,推荐一个,scrapy,

用到localstorage类型就行了,

按你的条件, 查看全部

无规则采集器列表算法你并没有把这两个做对比

无规则采集器列表算法你并没有把这两个做对比,正如其他答主所说,他们有不同的业务类型,而且采集速度也是影响速度的关键因素,关键字词是我们的核心,或者说是我们使用各个采集器最先考虑的,我可以提供一个操作清单,知道我用什么采集器,一键对应的时候应该怎么去调用。附链接。

来源:。开放接口的,可以私信下。这只是普通的自动化接口。详细可以去黑帽seo论坛找下,有各种自动化采集的教程。

都可以抓取站外信息,关键是你要理解搜索引擎的工作原理。

然而谁有规则速度快分分钟,不信你试试。

技术不一样,所以不要想着用采集器操作,这样的还得和人打交道,来回返工,很费事的。规则用采集器解决。

我用过明道比较好,

我不知道python适合或者不适合,但是我知道传说中的kwf,scrapy,pymdk都是针对性蛮强的工具,在上面工作个几年肯定收获颇丰。我就不在这边介绍了。但是我想说,每个人有适合自己的方法,就像我现在做的就挺好,

不清楚你是不是it,如果有本事自己写爬虫,推荐一个,scrapy,

用到localstorage类型就行了,

按你的条件,

考拉SEO:如何凭借软件24小时生产1万篇原创文章

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-05-18 19:17

Koala SEO [批处理SEO 原创 文章]平台支持本文。借助考拉,一天之内就可以制作成千上万的高质量SEO文章文章!

非常抱歉,当大人物进入文章时,他们可能会没有规则就无法获取有关采集器的信息,因为此页面是我们平台智能编写的SEO 文章。如果每个人都对这批原创 网站的信息感兴趣,那么将采集器放在无规则的地方,让我指导您理解:如何使用软件在24小时内产生10,000个优化原创 ] 文本!许多朋友在编辑器中阅读了这些信息,并认为这是伪原创平台,错了!实际上,我们是一个原创工具,关键词和模板是为每个人编写的,很难找到,并且文章的生成内容彼此相似。这个平台是如何设计的?接下来,我会给您详细的解释!

我很想询问采集器的不使用规则的合作伙伴。老实说,每个人都珍惜的是本文前面提到的问题。最初原创的几项优质排水降落物品做得很好,但其中一篇文章的流量却很少。我希望使用文章布局来完成流量的目的。最重要的方法是批量生产!假设一个网页文章可以得到1 UV(1天),也就是说,假设可以写10,000篇文章,那么平均每日客户量就可以增加数万。但是,简单地说,实际上,一个人一天只能写大约30篇文章,最多只能写70篇文章。即使使用伪原创平台,最多也将有大约100篇文章!现在我们已经看到了这一点,我们应该抛开采集器的问题(这不是一个规则),并研究如何完成文章的自动编写!

什么是经过算法批准的人工编辑器? seo 原创不等于写单词原创!在每个搜索者的系统定义中,原创并不意味着没有邮政重复。从逻辑上讲,每当我们的代码字与其他文章不同时,被索引的可能性就会大大增加。好的文章,其内容足够醒目,坚持相同的目标词,只要确认没有重复大的段落,那么此文章还是很有可能被识别出来,或者甚至成为热门。例如,在我的文章中,您可能没有规则采集器地在搜索引擎中进行了搜索,最后单击以查看它。您可以告诉您,此文章是使用可轻松导出的Koala系统文章软件的AI编写的!

Koala SEO的AI 原创工具应称为手动编写文章软件,该软件可在三个小时内完成成千上万的网站文案写作。通常网站的质量就足够了。高收录可以高达79%。有关如何使用它的详细教程。用户主页收录视频显示和入门指南。大家伙们可以一开始就使用它!很抱歉,没有为您提供关于采集器不适用规则的详细说明。也许它使您浏览了这样的废话。 文章。但是,如果您对Koala的软件感兴趣,只需打开菜单栏,每天将我们的页面增加数千万紫外线。不可靠吗? 查看全部

考拉SEO:如何凭借软件24小时生产1万篇原创文章

Koala SEO [批处理SEO 原创 文章]平台支持本文。借助考拉,一天之内就可以制作成千上万的高质量SEO文章文章!

非常抱歉,当大人物进入文章时,他们可能会没有规则就无法获取有关采集器的信息,因为此页面是我们平台智能编写的SEO 文章。如果每个人都对这批原创 网站的信息感兴趣,那么将采集器放在无规则的地方,让我指导您理解:如何使用软件在24小时内产生10,000个优化原创 ] 文本!许多朋友在编辑器中阅读了这些信息,并认为这是伪原创平台,错了!实际上,我们是一个原创工具,关键词和模板是为每个人编写的,很难找到,并且文章的生成内容彼此相似。这个平台是如何设计的?接下来,我会给您详细的解释!

我很想询问采集器的不使用规则的合作伙伴。老实说,每个人都珍惜的是本文前面提到的问题。最初原创的几项优质排水降落物品做得很好,但其中一篇文章的流量却很少。我希望使用文章布局来完成流量的目的。最重要的方法是批量生产!假设一个网页文章可以得到1 UV(1天),也就是说,假设可以写10,000篇文章,那么平均每日客户量就可以增加数万。但是,简单地说,实际上,一个人一天只能写大约30篇文章,最多只能写70篇文章。即使使用伪原创平台,最多也将有大约100篇文章!现在我们已经看到了这一点,我们应该抛开采集器的问题(这不是一个规则),并研究如何完成文章的自动编写!

什么是经过算法批准的人工编辑器? seo 原创不等于写单词原创!在每个搜索者的系统定义中,原创并不意味着没有邮政重复。从逻辑上讲,每当我们的代码字与其他文章不同时,被索引的可能性就会大大增加。好的文章,其内容足够醒目,坚持相同的目标词,只要确认没有重复大的段落,那么此文章还是很有可能被识别出来,或者甚至成为热门。例如,在我的文章中,您可能没有规则采集器地在搜索引擎中进行了搜索,最后单击以查看它。您可以告诉您,此文章是使用可轻松导出的Koala系统文章软件的AI编写的!

Koala SEO的AI 原创工具应称为手动编写文章软件,该软件可在三个小时内完成成千上万的网站文案写作。通常网站的质量就足够了。高收录可以高达79%。有关如何使用它的详细教程。用户主页收录视频显示和入门指南。大家伙们可以一开始就使用它!很抱歉,没有为您提供关于采集器不适用规则的详细说明。也许它使您浏览了这样的废话。 文章。但是,如果您对Koala的软件感兴趣,只需打开菜单栏,每天将我们的页面增加数千万紫外线。不可靠吗?

无规则采集器列表算法,如何学习规则存储库列表

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2021-05-16 00:22

无规则采集器列表算法我们在前面介绍了最基本的文本爬虫存储库列表算法,其实规则的存储库列表算法非常简单,我们应该先学习的是规则的存储库列表算法的基本思想。在学习规则的存储库列表算法的时候,我们需要明白一点,就是在学习规则存储库列表算法之前,我们必须要熟悉爬虫的运行原理和解析规则库列表算法。毕竟,规则的存储库列表算法在爬虫运行的过程中属于一个很重要的组成部分,要想熟练的掌握规则的存储库列表算法,最重要的是先了解爬虫的运行原理和解析规则库列表算法。

在学习规则存储库列表算法之前,我们先看一下规则存储库列表算法有哪些的一些基本原理。规则存储库列表算法有几种可以存储多个规则分词的列表存储方法,我们在最基本的列表采集库中详细介绍。如果要同时存储多个,一般来说,我们可以使用链表或者字典存储在数组中。数组的优点是可以存放不同数据类型,存取速度非常快,而且,能够同时存放多个分词规则。

链表的优点是不仅能够存放不同数据类型,而且可以同时存放多个词语。对于一个新的词语,我们需要遍历链表的前部分才能够找到下一个符合要求的词语,而对于整个文本,我们就需要遍历整个链表。了解规则存储库列表算法的基本思想之后,我们再来详细说说如何学习规则存储库列表算法。那么,在怎么才能学习规则存储库列表算法呢?其实很简单,在爬虫的运行中,我们有request对象就可以进行规则存储库列表算法,比如我们在爬虫运行的过程中需要存放你的名字phone这个词的规则,在我们爬虫的运行过程中有class对象就可以进行规则存储库列表算法的学习。

这就是很简单规则存储库列表算法。在我们找到分词规则之后,我们只需要简单的调用下就可以在我们的系统中,直接看到我们需要的分词规则。我们的系统就可以像规则存储库一样,可以直接对爬虫直接产生规则。爬虫一般的规则存储库大小为200-500k,我们可以在我们的规则存储库中加入少量的字符,但是,我们必须要一定要将爬虫本身规则存储库的大小需要限制在500k之内。

或者,我们可以采用广播机或者采用循环遍历机,定时的将我们的爬虫从请求记录中采集出来的规则进行输出。这样我们不仅可以在我们的系统中看到我们需要分词的规则,同时,也可以定时对爬虫采集出来的规则进行输出。如果我们将爬虫的规则存储库大小保持在500k之内,也可以在我们的爬虫中,对我们采集出来的规则,设置一定的门槛:必须要在worker线程中进行读取和调用。也就是说,我们需要维护爬虫的thread的结构,只能够爬虫本身进行读取和读取规则的读取, 查看全部

无规则采集器列表算法,如何学习规则存储库列表

无规则采集器列表算法我们在前面介绍了最基本的文本爬虫存储库列表算法,其实规则的存储库列表算法非常简单,我们应该先学习的是规则的存储库列表算法的基本思想。在学习规则的存储库列表算法的时候,我们需要明白一点,就是在学习规则存储库列表算法之前,我们必须要熟悉爬虫的运行原理和解析规则库列表算法。毕竟,规则的存储库列表算法在爬虫运行的过程中属于一个很重要的组成部分,要想熟练的掌握规则的存储库列表算法,最重要的是先了解爬虫的运行原理和解析规则库列表算法。

在学习规则存储库列表算法之前,我们先看一下规则存储库列表算法有哪些的一些基本原理。规则存储库列表算法有几种可以存储多个规则分词的列表存储方法,我们在最基本的列表采集库中详细介绍。如果要同时存储多个,一般来说,我们可以使用链表或者字典存储在数组中。数组的优点是可以存放不同数据类型,存取速度非常快,而且,能够同时存放多个分词规则。

链表的优点是不仅能够存放不同数据类型,而且可以同时存放多个词语。对于一个新的词语,我们需要遍历链表的前部分才能够找到下一个符合要求的词语,而对于整个文本,我们就需要遍历整个链表。了解规则存储库列表算法的基本思想之后,我们再来详细说说如何学习规则存储库列表算法。那么,在怎么才能学习规则存储库列表算法呢?其实很简单,在爬虫的运行中,我们有request对象就可以进行规则存储库列表算法,比如我们在爬虫运行的过程中需要存放你的名字phone这个词的规则,在我们爬虫的运行过程中有class对象就可以进行规则存储库列表算法的学习。

这就是很简单规则存储库列表算法。在我们找到分词规则之后,我们只需要简单的调用下就可以在我们的系统中,直接看到我们需要的分词规则。我们的系统就可以像规则存储库一样,可以直接对爬虫直接产生规则。爬虫一般的规则存储库大小为200-500k,我们可以在我们的规则存储库中加入少量的字符,但是,我们必须要一定要将爬虫本身规则存储库的大小需要限制在500k之内。

或者,我们可以采用广播机或者采用循环遍历机,定时的将我们的爬虫从请求记录中采集出来的规则进行输出。这样我们不仅可以在我们的系统中看到我们需要分词的规则,同时,也可以定时对爬虫采集出来的规则进行输出。如果我们将爬虫的规则存储库大小保持在500k之内,也可以在我们的爬虫中,对我们采集出来的规则,设置一定的门槛:必须要在worker线程中进行读取和调用。也就是说,我们需要维护爬虫的thread的结构,只能够爬虫本身进行读取和读取规则的读取,

社区一员可以使用csdn爬取所有网站的爬虫返回时间

采集交流 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2021-05-13 22:02

无规则采集器列表算法的迭代是预先设定好的,根据反爬虫ai的估计比例去重加工,判断多少种算法对应多少个ip。一句话总结就是通过算法区分多少个ip对应多少个ip,同时去重加工。我相信我们能够从openid去重加工出各种操作系统的每一台主机,从而找到这些主机下能够代表用户的操作系统。

很多了,我都在用。一般是:从产品介绍看是大量ip从产品使用者访问记录看主机总数不过那些需要访问才能获取到的信息大多不公开出来,怎么估算就不清楚了。

每次登陆均会对链接中的某些子链加分,对加分较多的该页面重点爬取。ps:作为社区一员可以使用csdn爬取所有网站的爬虫,学习新技术都是互相分享的。

专门的网站爬虫:http请求、特征检测等。比如paper,wiki,这类的,每一次爬取只存入一个url对象,里面存储请求ip,firstname,lastname、正则等key,每次请求都会返回一个url对象。其他网站爬虫:一般用于产品调研,有时也会被请求,他们都要公开这些数据。

java工程师都知道需要一个cookie,爬虫的登录验证码就用到了cookie。爬虫肯定要定时更新,一方面进行正则匹配,另一方面对比现有的广告文案。

一般有对应的ip,登录ip的算法要多少。ip会根据ai算法进行匹配,然后根据比例用一个总的url对应这个ip对应某产品登录页面。要是说使用的规则,常用的大概有:post发送前检查加密问题,页面js判断来源ip,采用referer伪装不同网站,页面scrapy轮循或者进程单步过滤验证登录(怎么判断访问频率自己定义爬虫返回时间)。

知道产品来源的情况下也可以进行比例计算,当然关键在于怎么计算比例。一般来说ip的规则是进程单步一个页面中多次访问情况下的总和-1。 查看全部

社区一员可以使用csdn爬取所有网站的爬虫返回时间

无规则采集器列表算法的迭代是预先设定好的,根据反爬虫ai的估计比例去重加工,判断多少种算法对应多少个ip。一句话总结就是通过算法区分多少个ip对应多少个ip,同时去重加工。我相信我们能够从openid去重加工出各种操作系统的每一台主机,从而找到这些主机下能够代表用户的操作系统。

很多了,我都在用。一般是:从产品介绍看是大量ip从产品使用者访问记录看主机总数不过那些需要访问才能获取到的信息大多不公开出来,怎么估算就不清楚了。

每次登陆均会对链接中的某些子链加分,对加分较多的该页面重点爬取。ps:作为社区一员可以使用csdn爬取所有网站的爬虫,学习新技术都是互相分享的。

专门的网站爬虫:http请求、特征检测等。比如paper,wiki,这类的,每一次爬取只存入一个url对象,里面存储请求ip,firstname,lastname、正则等key,每次请求都会返回一个url对象。其他网站爬虫:一般用于产品调研,有时也会被请求,他们都要公开这些数据。

java工程师都知道需要一个cookie,爬虫的登录验证码就用到了cookie。爬虫肯定要定时更新,一方面进行正则匹配,另一方面对比现有的广告文案。

一般有对应的ip,登录ip的算法要多少。ip会根据ai算法进行匹配,然后根据比例用一个总的url对应这个ip对应某产品登录页面。要是说使用的规则,常用的大概有:post发送前检查加密问题,页面js判断来源ip,采用referer伪装不同网站,页面scrapy轮循或者进程单步过滤验证登录(怎么判断访问频率自己定义爬虫返回时间)。

知道产品来源的情况下也可以进行比例计算,当然关键在于怎么计算比例。一般来说ip的规则是进程单步一个页面中多次访问情况下的总和-1。

无规则采集器列表算法图书馆群采集图书资源采集网站

采集交流 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2021-05-12 00:02

无规则采集器列表算法图书馆群采集图书资源采集网站根据ai算法,获取书籍资源的属性点,人工智能采集图书资源,可以得到很多有用的书籍资源,比如你要找童书,那么直接使用ai算法,就可以得到童书相关的属性点,再点击分析结果,即可获取分析后的童书资源数据,这是获取书籍资源的最原始方法。ai算法获取资源的精度难免存在局限性,所以要用到下面三种算法才能获取到数据。算法。

一、机器学习之1-算法

二、特征工程之3-算法

三、可视化分析之4如果认为本文为原创,请点赞或关注我!如果没有任何贡献,欢迎点没有帮助!关注“非官方推荐机器学习资源”公众号,

人工智能获取书籍比较难,而且常常需要机器学习/神经网络/深度学习技术来进行一些标注,这就增加了资源获取难度。如果有一些技术经验并且已经掌握了算法,那可以尝试去以最少的算法去获取数据,然后使用可视化深度学习技术一层一层的去挖掘。当然如果书籍数量较多,一次就挖掘完毕也有可能,或者挖掘到知识点后再去次更深的挖掘,这样效率会更高。不过个人认为现在的人工智能书籍很多还是在数量上和方法上面很多欠缺。

在数据收集方面,目前来看普遍有以下几种方法:人工去收集书籍,机器去收集书籍,算法去收集书籍。机器去收集,这里一般是用来快速分析的,基本上可以直接用,代价低,不需要人工去关注;算法去收集,这里是用来查找资源的,需要自己编程去查找,或者是人工对书籍进行排序。如果有智能算法去,收集的速度会更快。在数据挖掘方面,目前可以通过机器学习去分析,或者人工智能算法。 查看全部

无规则采集器列表算法图书馆群采集图书资源采集网站

无规则采集器列表算法图书馆群采集图书资源采集网站根据ai算法,获取书籍资源的属性点,人工智能采集图书资源,可以得到很多有用的书籍资源,比如你要找童书,那么直接使用ai算法,就可以得到童书相关的属性点,再点击分析结果,即可获取分析后的童书资源数据,这是获取书籍资源的最原始方法。ai算法获取资源的精度难免存在局限性,所以要用到下面三种算法才能获取到数据。算法。

一、机器学习之1-算法

二、特征工程之3-算法

三、可视化分析之4如果认为本文为原创,请点赞或关注我!如果没有任何贡献,欢迎点没有帮助!关注“非官方推荐机器学习资源”公众号,

人工智能获取书籍比较难,而且常常需要机器学习/神经网络/深度学习技术来进行一些标注,这就增加了资源获取难度。如果有一些技术经验并且已经掌握了算法,那可以尝试去以最少的算法去获取数据,然后使用可视化深度学习技术一层一层的去挖掘。当然如果书籍数量较多,一次就挖掘完毕也有可能,或者挖掘到知识点后再去次更深的挖掘,这样效率会更高。不过个人认为现在的人工智能书籍很多还是在数量上和方法上面很多欠缺。

在数据收集方面,目前来看普遍有以下几种方法:人工去收集书籍,机器去收集书籍,算法去收集书籍。机器去收集,这里一般是用来快速分析的,基本上可以直接用,代价低,不需要人工去关注;算法去收集,这里是用来查找资源的,需要自己编程去查找,或者是人工对书籍进行排序。如果有智能算法去,收集的速度会更快。在数据挖掘方面,目前可以通过机器学习去分析,或者人工智能算法。

大数据技术对比国内外十大主流采集软件的优缺点

采集交流 • 优采云 发表了文章 • 0 个评论 • 364 次浏览 • 2021-05-10 20:25

大数据技术对比国内外十大主流采集软件的优缺点

大数据技术已经发展了多年,它已经从看起来很酷的新技术变成了企业在生产和运营中实际部署的服务。其中,data 采集产品迎来了广阔的市场前景,国内外市场上有许多具有不同技术一、和不平衡采集的采集软件。

今天,我们将比较国内外十种主流采集软件的优缺点,以帮助您选择最合适的爬虫并体验数据狩猎的乐趣。

国内文章

1. 优采云

优采云作为采集世界的旧版本,是一种Internet数据捕获,处理,分析和挖掘软件,可以捕获Web上分散的数据信息,并通过一系列分析和处理,是准确的挖出所需的数据。它的用户定位主要是针对具有一定代码库的人员,适合于对退伍军人进行编程。

结论:优采云适合编程专家,规则更复杂,软件定位更加专业,准确。

2. 优采云

无需视觉编程的网页采集软件,可以快速从不同的网站中提取标准化数据,帮助用户实现数据自动化采集,编辑和标准化,并降低工作成本。云采集是其主要功能。与其他采集软件相比,云采集可以更加精确,高效和大规模。

结论:优采云是适合新手用户试用的采集软件。它具有强大的云功能。当然,爬虫的资深人士也可以开发其高级功能。

3.采集客户

一个简单易用的Web信息爬网软件,可以捕获网页文本,图表,超链接和其他Web元素。它也可以通过简单的可视化过程采集进行,以为需要数据的任何人采集服务。

结论:采集和采集客户的操作相对简单,适合初学者。就功能而言,功能并不多,对后续付款的要求也更高。

4. 优采云云端爬虫

基于优采云分布式云采集器框架的新型云在线智能采集器/ 采集器可帮助用户快速获取大量标准化的Web数据。

结论:优采云与爬虫系统框架相似,具体来说采集要求用户编写自己的爬虫,并且需要代码基础。

5. 优采云 采集器

一套专业的网站内容采集软件,支持各种论坛帖子和回复采集,网站和博客文章内容捕获,子论坛采集器,cms 采集器和Blog 采集器是三种类型。

结论:专注于论坛和博客文本内容的爬网。 采集对于整个网络数据不是很通用。

外国文章

1. Import.io

Import.io是基于Web的网页数据采集平台,用户可以生成提取器,而无需编写代码并单击它。与大多数国产采集软件相比,Import.io更加智能,可以匹配并生成相似元素的列表,用户还可以输入带有一个关键采集数据的URL。

结论:Import.io智能开发,采集很简单,但是对于某些复杂的网页结构,它的处理能力相对较弱。

2. Octoparse

Octoparse是功能齐全的Internet 采集工具,其中内置了许多高效工具。用户无需编写代码即可从复杂的网页结构中采集结构化数据。 采集页面设计简单友好,完全可视化,适合新手用户。

结论:Octoparse具有完整的功能和合理的价格。它可以应用于复杂的网页结构。如果您想直接使用Amazon,Facebook,Twitter和其他平台,则可以选择Octoparse。

3. Visual Web Ripper

Visual Web Ripper是支持各种功能的自动Web抓取工具。它适用于某些高级采集困难的网页结构,并且用户需要具有较强的编程技能。

结论:Visual Web Ripper具有强大的功能和强大的自定义采集能力,适合具有丰富编程经验的用户使用。它不提供云采集服务,这可能会限制采集的效率。

4. Content Grabber

Content Grabber是最强大的Web抓取工具之一。它更适合具有高级编程技能的人,并提供许多强大的脚本编辑和调试界面。允许用户编写正则表达式,而不使用内置工具。

结论:Content Grabber网页具有很强的适用性和强大的功能。它不能完全为用户提供基本功能,并且适合具有高级编程技能的人。

5. Mozenda

Mozenda是基于云的数据采集软件,可为用户提供许多实用功能,包括数据云存储。

结论:Mozenda提供数据云存储,但是难以处理复杂的网页结构,软件操作界面跳转,用户体验不够友好,并且适合具有基本爬虫经验的人。

以上的爬虫软件已经能够满足国内外用户的采集需要。一些工具,例如优采云,优采云,Octoparse和Content Grabber,提供了许多高级功能来帮助用户使用内置的Regex。 XPath工具和代理服务器可从复杂的网页中抓取准确的数据。

不建议没有编程基础的用户选择优采云,Content Grabber和其他需要自定义编程的工具。当然,这完全取决于个人需求,毕竟最适合您的是! 查看全部

大数据技术对比国内外十大主流采集软件的优缺点

大数据技术已经发展了多年,它已经从看起来很酷的新技术变成了企业在生产和运营中实际部署的服务。其中,data 采集产品迎来了广阔的市场前景,国内外市场上有许多具有不同技术一、和不平衡采集的采集软件。

今天,我们将比较国内外十种主流采集软件的优缺点,以帮助您选择最合适的爬虫并体验数据狩猎的乐趣。

国内文章

1. 优采云

优采云作为采集世界的旧版本,是一种Internet数据捕获,处理,分析和挖掘软件,可以捕获Web上分散的数据信息,并通过一系列分析和处理,是准确的挖出所需的数据。它的用户定位主要是针对具有一定代码库的人员,适合于对退伍军人进行编程。

结论:优采云适合编程专家,规则更复杂,软件定位更加专业,准确。

2. 优采云

无需视觉编程的网页采集软件,可以快速从不同的网站中提取标准化数据,帮助用户实现数据自动化采集,编辑和标准化,并降低工作成本。云采集是其主要功能。与其他采集软件相比,云采集可以更加精确,高效和大规模。

结论:优采云是适合新手用户试用的采集软件。它具有强大的云功能。当然,爬虫的资深人士也可以开发其高级功能。

3.采集客户

一个简单易用的Web信息爬网软件,可以捕获网页文本,图表,超链接和其他Web元素。它也可以通过简单的可视化过程采集进行,以为需要数据的任何人采集服务。

结论:采集和采集客户的操作相对简单,适合初学者。就功能而言,功能并不多,对后续付款的要求也更高。

4. 优采云云端爬虫

基于优采云分布式云采集器框架的新型云在线智能采集器/ 采集器可帮助用户快速获取大量标准化的Web数据。

结论:优采云与爬虫系统框架相似,具体来说采集要求用户编写自己的爬虫,并且需要代码基础。

5. 优采云 采集器

一套专业的网站内容采集软件,支持各种论坛帖子和回复采集,网站和博客文章内容捕获,子论坛采集器,cms 采集器和Blog 采集器是三种类型。

结论:专注于论坛和博客文本内容的爬网。 采集对于整个网络数据不是很通用。

外国文章

1. Import.io

Import.io是基于Web的网页数据采集平台,用户可以生成提取器,而无需编写代码并单击它。与大多数国产采集软件相比,Import.io更加智能,可以匹配并生成相似元素的列表,用户还可以输入带有一个关键采集数据的URL。

结论:Import.io智能开发,采集很简单,但是对于某些复杂的网页结构,它的处理能力相对较弱。

2. Octoparse

Octoparse是功能齐全的Internet 采集工具,其中内置了许多高效工具。用户无需编写代码即可从复杂的网页结构中采集结构化数据。 采集页面设计简单友好,完全可视化,适合新手用户。

结论:Octoparse具有完整的功能和合理的价格。它可以应用于复杂的网页结构。如果您想直接使用Amazon,Facebook,Twitter和其他平台,则可以选择Octoparse。

3. Visual Web Ripper

Visual Web Ripper是支持各种功能的自动Web抓取工具。它适用于某些高级采集困难的网页结构,并且用户需要具有较强的编程技能。

结论:Visual Web Ripper具有强大的功能和强大的自定义采集能力,适合具有丰富编程经验的用户使用。它不提供云采集服务,这可能会限制采集的效率。

4. Content Grabber

Content Grabber是最强大的Web抓取工具之一。它更适合具有高级编程技能的人,并提供许多强大的脚本编辑和调试界面。允许用户编写正则表达式,而不使用内置工具。

结论:Content Grabber网页具有很强的适用性和强大的功能。它不能完全为用户提供基本功能,并且适合具有高级编程技能的人。

5. Mozenda

Mozenda是基于云的数据采集软件,可为用户提供许多实用功能,包括数据云存储。

结论:Mozenda提供数据云存储,但是难以处理复杂的网页结构,软件操作界面跳转,用户体验不够友好,并且适合具有基本爬虫经验的人。

以上的爬虫软件已经能够满足国内外用户的采集需要。一些工具,例如优采云,优采云,Octoparse和Content Grabber,提供了许多高级功能来帮助用户使用内置的Regex。 XPath工具和代理服务器可从复杂的网页中抓取准确的数据。

不建议没有编程基础的用户选择优采云,Content Grabber和其他需要自定义编程的工具。当然,这完全取决于个人需求,毕竟最适合您的是!

无规则采集器列表算法详解及voip测试服破解版

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-05-09 21:03

无规则采集器列表算法详解及voip测试服破解版[pdf]大家推荐的破解版已经不能在公安和教育局系统使用。推荐别人的破解版只支持tcp和udp,问题不大,但是每次都要转udp太麻烦。我这里发现一款破解版支持tcp和udp全支持。支持国内主流论坛以及教育局系统。如下:大家可以试试。万一可用呢。我只推荐教育局可用的版本。支持免费试用:30天,必须绑定学号,失效后收费480.。

网页版华科云ai采集,直接在网页里进行采集,然后进行测试。国内比较知名的网页采集工具。

这里有一个免费,不收取任何费用的采集软件,,欢迎来骚扰。

charles直接过滤所有抓取请求

推荐我知道的,flashind,这个适合测试用,它会自动屏蔽所有抓取请求,采集成功率还不错,

自行用过flashind,老牌的newify采集工具,主要针对会议和项目ppt,采集成功率较高,测试通过率可以达到80%以上,对付国内的限制压力比较小.楼主还是用seoworthy吧,前段时间用他采集了一张ppt,测试成功.全是手机浏览器上的端对端访问.

去中国采集网

我手头正在用一个workflowy采集文章,效果还不错。在后台上传下载,不用到别人那里下载。 查看全部

无规则采集器列表算法详解及voip测试服破解版

无规则采集器列表算法详解及voip测试服破解版[pdf]大家推荐的破解版已经不能在公安和教育局系统使用。推荐别人的破解版只支持tcp和udp,问题不大,但是每次都要转udp太麻烦。我这里发现一款破解版支持tcp和udp全支持。支持国内主流论坛以及教育局系统。如下:大家可以试试。万一可用呢。我只推荐教育局可用的版本。支持免费试用:30天,必须绑定学号,失效后收费480.。

网页版华科云ai采集,直接在网页里进行采集,然后进行测试。国内比较知名的网页采集工具。

这里有一个免费,不收取任何费用的采集软件,,欢迎来骚扰。

charles直接过滤所有抓取请求

推荐我知道的,flashind,这个适合测试用,它会自动屏蔽所有抓取请求,采集成功率还不错,

自行用过flashind,老牌的newify采集工具,主要针对会议和项目ppt,采集成功率较高,测试通过率可以达到80%以上,对付国内的限制压力比较小.楼主还是用seoworthy吧,前段时间用他采集了一张ppt,测试成功.全是手机浏览器上的端对端访问.

去中国采集网

我手头正在用一个workflowy采集文章,效果还不错。在后台上传下载,不用到别人那里下载。

无规则采集器列表算法在这里,百度经验编辑规则

采集交流 • 优采云 发表了文章 • 0 个评论 • 203 次浏览 • 2021-05-07 03:02

无规则采集器列表算法在这里,百度经验编辑规则,请先点链接《精通百度经验采集,一点不难》--博客频道,采集客户端支持雅虎、google、bing等,兼容windows、mac、linux。在我这里可以完全兼容网站。

三天收集40w有点扯,运气还是要有的。如果有大佬愿意来回答这个问题估计能收集个数百万,当然要上交工作,毕竟采集没有技术含量,很容易被系统自动把你的自动回复给折叠了。用excel、word等文档类型采集出来的效果不如采集网页网站的网页效果好。不信你就自己试试。我给的地址好像就一个二维码,如果不说是百度还是其他家的,或者要登录,要等很久。

我来顶一下上面的。——这个问题十一月中旬刚提出来,因为老婆生孩子生完孩子后就一直没上网,现在就陆陆续续有人发给我,而且都是一些已有比较大流量的网站,加之经验和学识较少,不知道里面都有些什么,总是不能很好的了解目标网站的用户体验,出去一趟回来就发现能上的网站也就40多家。想想这么多流量网站,至今都能成百万上千万,打开cnbeta这些平台过后,一看已被大量站采集并且订阅,由此推测其用户活跃度应该不低,未来可为制造事故准备好因素。

下面就先试着写几个,回头再在提问中补充吧。[更新]我写的是入门级的(今天第三次修改),有大量错误,且不够接地气,还希望谅解。*o>据我了解,这个多图采集,需要cdn加速,所以同时要开多台机器。query_generator是个免费工具。{"query_generator":{"browser_client":"","client_port":"8800","proxy_base_port":80},"target_country":3,"mime_type":"text/plain","multipart_tag":"zh-cn","user_agent":"mozilla/5.0(windowsnt6.1;win64;x64)applewebkit/537.36(khtml,likegecko)chrome/71.0.2304.87safari/537.36","user_modules":["cfgui"],"user_folder_len":"00。 查看全部

无规则采集器列表算法在这里,百度经验编辑规则

无规则采集器列表算法在这里,百度经验编辑规则,请先点链接《精通百度经验采集,一点不难》--博客频道,采集客户端支持雅虎、google、bing等,兼容windows、mac、linux。在我这里可以完全兼容网站。

三天收集40w有点扯,运气还是要有的。如果有大佬愿意来回答这个问题估计能收集个数百万,当然要上交工作,毕竟采集没有技术含量,很容易被系统自动把你的自动回复给折叠了。用excel、word等文档类型采集出来的效果不如采集网页网站的网页效果好。不信你就自己试试。我给的地址好像就一个二维码,如果不说是百度还是其他家的,或者要登录,要等很久。

我来顶一下上面的。——这个问题十一月中旬刚提出来,因为老婆生孩子生完孩子后就一直没上网,现在就陆陆续续有人发给我,而且都是一些已有比较大流量的网站,加之经验和学识较少,不知道里面都有些什么,总是不能很好的了解目标网站的用户体验,出去一趟回来就发现能上的网站也就40多家。想想这么多流量网站,至今都能成百万上千万,打开cnbeta这些平台过后,一看已被大量站采集并且订阅,由此推测其用户活跃度应该不低,未来可为制造事故准备好因素。

下面就先试着写几个,回头再在提问中补充吧。[更新]我写的是入门级的(今天第三次修改),有大量错误,且不够接地气,还希望谅解。*o>据我了解,这个多图采集,需要cdn加速,所以同时要开多台机器。query_generator是个免费工具。{"query_generator":{"browser_client":"","client_port":"8800","proxy_base_port":80},"target_country":3,"mime_type":"text/plain","multipart_tag":"zh-cn","user_agent":"mozilla/5.0(windowsnt6.1;win64;x64)applewebkit/537.36(khtml,likegecko)chrome/71.0.2304.87safari/537.36","user_modules":["cfgui"],"user_folder_len":"00。

让我们从两个常见的内容采集工具开始:优采云采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-05-07 00:02

让我们从两个常见的内容采集工具入手:

([1) 优采云 采集工具:操作相对简单,免费版本可以满足新手网站管理员的数据挖掘需求,但是采集数据的派生需要集成,并且更重要的功能是智能采集,无需编写太复杂的规则。

([2) 优采云 采集器:家用集尘软件的旧品牌。因此,市场上有许多支持cms系统采集的插件,例如:织梦 文章 采集,WordPress信息采集,Zblog数据采集等。括号的扩展相对较大,但需要一定的技术力量。

那么,对于文章中的采集,我们应该注意哪些问题?

1、新电台消除了数据采集

我们知道网站发行的初始阶段有一个评估期。如果我们在车站大楼的开始使用采集到的内容,它将对网站的评级产生影响。 文章很容易放入低质量的库中,并且会出现一个普遍现象:收录中没有排名。

基于这个原因,Xin 网站尝试将原创内容保留在Internet上,并且当页面内容未完全编入索引时,则无需盲目提交,或者如果您要提交,则需要采用某些策略。

2、网站重量采集内容

我们知道搜索引擎不喜欢关闭状态。他们喜欢的网站不仅具有导入链接,而且还需要一些导出链接以使该生态系统更加相关。

为此,当您的网站积累了一定的分量时,您可以通过版权链接适当地采集相关内容,并且需要注意:

(1)确保内容采集对网站上的用户有一定的推荐价值,这是解决用户需求的好方法。

(2)行业官方文档,重量级网站,著名的推荐采集内容。

3、避免在整个网站上使用采集个内容

说到这个问题,很多人很容易质疑飓风算法对获取的严厉攻击的重要性,但是为什么著名的网站不在攻击范围之内?

这与搜索引擎的性质有关:满足用户的需求,网站对高质量内容的传播的影响也相对重要。

对于中小型网站,在具有独特的属性和影响力之前,我们应尽量避免过多的内容采集。

提醒:随着熊掌的引入和原创保护的引入,百度仍将努力调整和平衡原创的内容和著名的网站的排名。原则上,应该更倾向于对原创站点的统治进行排名。

4、如果惩罚网站 采集的内容该怎么办?

飓风算法非常人性化。它只会惩罚采集列,但对同一站点上的其他列影响很小。

因此,解决方案非常简单,您只需要删除采集的内容并设置404页面,然后在百度搜索资源平台中提交无效链接-> 网站支持->数据介绍->无效链接提交列。如果您发现网站的权重恢复缓慢,则可以在反馈中心提供反馈。

摘要:该内容仍适用于Wang。如果您关注Bear Paw,您会发现百度将在2019年增加对原创内容的支持,并尽量避免采集内容。 查看全部

让我们从两个常见的内容采集工具开始:优采云采集

让我们从两个常见的内容采集工具入手:

([1) 优采云 采集工具:操作相对简单,免费版本可以满足新手网站管理员的数据挖掘需求,但是采集数据的派生需要集成,并且更重要的功能是智能采集,无需编写太复杂的规则。

([2) 优采云 采集器:家用集尘软件的旧品牌。因此,市场上有许多支持cms系统采集的插件,例如:织梦 文章 采集,WordPress信息采集,Zblog数据采集等。括号的扩展相对较大,但需要一定的技术力量。

那么,对于文章中的采集,我们应该注意哪些问题?

1、新电台消除了数据采集

我们知道网站发行的初始阶段有一个评估期。如果我们在车站大楼的开始使用采集到的内容,它将对网站的评级产生影响。 文章很容易放入低质量的库中,并且会出现一个普遍现象:收录中没有排名。

基于这个原因,Xin 网站尝试将原创内容保留在Internet上,并且当页面内容未完全编入索引时,则无需盲目提交,或者如果您要提交,则需要采用某些策略。

2、网站重量采集内容

我们知道搜索引擎不喜欢关闭状态。他们喜欢的网站不仅具有导入链接,而且还需要一些导出链接以使该生态系统更加相关。

为此,当您的网站积累了一定的分量时,您可以通过版权链接适当地采集相关内容,并且需要注意:

(1)确保内容采集对网站上的用户有一定的推荐价值,这是解决用户需求的好方法。

(2)行业官方文档,重量级网站,著名的推荐采集内容。

3、避免在整个网站上使用采集个内容

说到这个问题,很多人很容易质疑飓风算法对获取的严厉攻击的重要性,但是为什么著名的网站不在攻击范围之内?

这与搜索引擎的性质有关:满足用户的需求,网站对高质量内容的传播的影响也相对重要。

对于中小型网站,在具有独特的属性和影响力之前,我们应尽量避免过多的内容采集。

提醒:随着熊掌的引入和原创保护的引入,百度仍将努力调整和平衡原创的内容和著名的网站的排名。原则上,应该更倾向于对原创站点的统治进行排名。

4、如果惩罚网站 采集的内容该怎么办?

飓风算法非常人性化。它只会惩罚采集列,但对同一站点上的其他列影响很小。

因此,解决方案非常简单,您只需要删除采集的内容并设置404页面,然后在百度搜索资源平台中提交无效链接-> 网站支持->数据介绍->无效链接提交列。如果您发现网站的权重恢复缓慢,则可以在反馈中心提供反馈。

摘要:该内容仍适用于Wang。如果您关注Bear Paw,您会发现百度将在2019年增加对原创内容的支持,并尽量避免采集内容。

无规则采集器列表算法设计图有什么含义呢?

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2021-05-04 04:03

无规则采集器列表算法设计图如下:图片有什么含义呢?①命令展示②成功字符③成功字符展示④数据格式分析只是单纯采集字符串数据,在你遇到这种不知道什么图像模式,什么采集图片等问题怎么办?可以看下面的规则设计图,当然最实用的是只用十行代码实现最终效果!1。学习资料:1。1教程1。2视频1。3源码。2。十行代码实现微信图片搜索。

有,说到排序就是,一个像素在世界上有1*1*1像素大小,如果排成一排,就是1*1*1*10像素大小,把所有相邻像素点连线。然后把所有像素点进行排序,排序可以百度一下顺序,比如日月星辰,或者朝代年月。

微信还没发布排序插件呢,

确定你的数据指的是图片还是文字?如果是图片,没有工具完成这个功能,还是需要程序员手工加载,相当于使用truetype矢量图片。如果是文字,也没有工具完成这个功能,毕竟字库是很大的。如果是文本,不仅需要工具,还需要有耐心学习字库格式。比如ascii码对应unicode里的字符。

真想花点时间学的话,我只知道你肯定会精通一些编程语言,比如ee,cs之类的。以及数据库的基本结构,指针,链表啥的。

首先你需要购买最新版的微信,一般热点是高级版本。然后你就可以开始编程了,根据小程序里的代码,写个函数,取特征值。要弄懂的是openurl,inurl。其实你需要用命令行的方式。你根据命令行的指令操作微信小程序的。以我的经验,运行在电脑上的微信,手机必须require过external。至于你说你用的是硬盘容量,可以用webdriver,但是你这么多字,你电脑损耗太大。我先用webdriver,再自己用电脑写。 查看全部

无规则采集器列表算法设计图有什么含义呢?

无规则采集器列表算法设计图如下:图片有什么含义呢?①命令展示②成功字符③成功字符展示④数据格式分析只是单纯采集字符串数据,在你遇到这种不知道什么图像模式,什么采集图片等问题怎么办?可以看下面的规则设计图,当然最实用的是只用十行代码实现最终效果!1。学习资料:1。1教程1。2视频1。3源码。2。十行代码实现微信图片搜索。

有,说到排序就是,一个像素在世界上有1*1*1像素大小,如果排成一排,就是1*1*1*10像素大小,把所有相邻像素点连线。然后把所有像素点进行排序,排序可以百度一下顺序,比如日月星辰,或者朝代年月。

微信还没发布排序插件呢,

确定你的数据指的是图片还是文字?如果是图片,没有工具完成这个功能,还是需要程序员手工加载,相当于使用truetype矢量图片。如果是文字,也没有工具完成这个功能,毕竟字库是很大的。如果是文本,不仅需要工具,还需要有耐心学习字库格式。比如ascii码对应unicode里的字符。

真想花点时间学的话,我只知道你肯定会精通一些编程语言,比如ee,cs之类的。以及数据库的基本结构,指针,链表啥的。

首先你需要购买最新版的微信,一般热点是高级版本。然后你就可以开始编程了,根据小程序里的代码,写个函数,取特征值。要弄懂的是openurl,inurl。其实你需要用命令行的方式。你根据命令行的指令操作微信小程序的。以我的经验,运行在电脑上的微信,手机必须require过external。至于你说你用的是硬盘容量,可以用webdriver,但是你这么多字,你电脑损耗太大。我先用webdriver,再自己用电脑写。

无规则采集器列表算法结构设计思路及实现办法快速的拓展性实验

采集交流 • 优采云 发表了文章 • 0 个评论 • 188 次浏览 • 2021-04-29 06:03

无规则采集器列表算法结构设计思路及实现办法快速的拓展性实验通过步步为营提高效率、改善性能剖析奇技淫巧面向对象,轮子哥一出手,从此有规律采集器代码大揭秘importsysreload(sys)sys.setdefaultencoding('utf-8')pre=sys.setdefaultencoding('utf-8')print("importsyspre=sys.setdefaultencoding('utf-8')print(pre.in_chars)")while循环用具体操作代替简单编程,少记一些死记硬背的规则语句中的细节。

正则表达式及patch类型定义代码在序列框内遍历序列importrequestsreg_d=requests.get("")[0]reg=requests.get("")[0]print("requests={}".format(reg_d[0]))ifrequests.exists(reg_d):print("requests={}".format(requests.exists(reg_d[0])))以下示例代码可以理解为轮子哥提供的数据源。

轮子哥的提高方法百度标签爬虫使用requests库实现了数据截取,实现了python网页应用的异步请求与解析,并将数据解析为二进制格式(str、python2中称为数组或字典等),再存入内存中存储。在代码中有两个变量用以储存二进制数据,str和int,str中保存的只是python编码中对应的数据类型(utf-。

8、gbk、big5等),int在python2中保存类型是整数的数据类型(int也可以理解为整数),在python3中保存类型仍为整数,而python编码中是float,而float保存的是浮点数值数据,数据不可保存在浮点数类型的数据中,通常python3中的float默认是浮点数值,每保存一个浮点数值需要转换成实数值,实质上float保存的数值并不是真正保存的数据,而是数据的格式转换后保存。

而使用requests库就可以免去重复操作url(默认定位到404页),

4)。

下面是代码:fromrequestsimportproxyheaders={'user-agent':'mozilla/5.0(windowsnt6.1;win64;x6

4)applewebkit/537。36(khtml,likegecko)chrome/73。3163。170safari/537。36'}s=proxy(headers=headers)r=requests。get(url=s)ifr。status_code==200:print("urlingtopurchase")s。

encoding='utf-8'else:print("urlingtourl")print("urlingtopassword")r。status_code=200print("urlingtopassword")ifr。status_code==300:print("urlingtopass。 查看全部

无规则采集器列表算法结构设计思路及实现办法快速的拓展性实验

无规则采集器列表算法结构设计思路及实现办法快速的拓展性实验通过步步为营提高效率、改善性能剖析奇技淫巧面向对象,轮子哥一出手,从此有规律采集器代码大揭秘importsysreload(sys)sys.setdefaultencoding('utf-8')pre=sys.setdefaultencoding('utf-8')print("importsyspre=sys.setdefaultencoding('utf-8')print(pre.in_chars)")while循环用具体操作代替简单编程,少记一些死记硬背的规则语句中的细节。

正则表达式及patch类型定义代码在序列框内遍历序列importrequestsreg_d=requests.get("")[0]reg=requests.get("")[0]print("requests={}".format(reg_d[0]))ifrequests.exists(reg_d):print("requests={}".format(requests.exists(reg_d[0])))以下示例代码可以理解为轮子哥提供的数据源。

轮子哥的提高方法百度标签爬虫使用requests库实现了数据截取,实现了python网页应用的异步请求与解析,并将数据解析为二进制格式(str、python2中称为数组或字典等),再存入内存中存储。在代码中有两个变量用以储存二进制数据,str和int,str中保存的只是python编码中对应的数据类型(utf-。

8、gbk、big5等),int在python2中保存类型是整数的数据类型(int也可以理解为整数),在python3中保存类型仍为整数,而python编码中是float,而float保存的是浮点数值数据,数据不可保存在浮点数类型的数据中,通常python3中的float默认是浮点数值,每保存一个浮点数值需要转换成实数值,实质上float保存的数值并不是真正保存的数据,而是数据的格式转换后保存。

而使用requests库就可以免去重复操作url(默认定位到404页),

4)。

下面是代码:fromrequestsimportproxyheaders={'user-agent':'mozilla/5.0(windowsnt6.1;win64;x6

4)applewebkit/537。36(khtml,likegecko)chrome/73。3163。170safari/537。36'}s=proxy(headers=headers)r=requests。get(url=s)ifr。status_code==200:print("urlingtopurchase")s。

encoding='utf-8'else:print("urlingtourl")print("urlingtopassword")r。status_code=200print("urlingtopassword")ifr。status_code==300:print("urlingtopass。

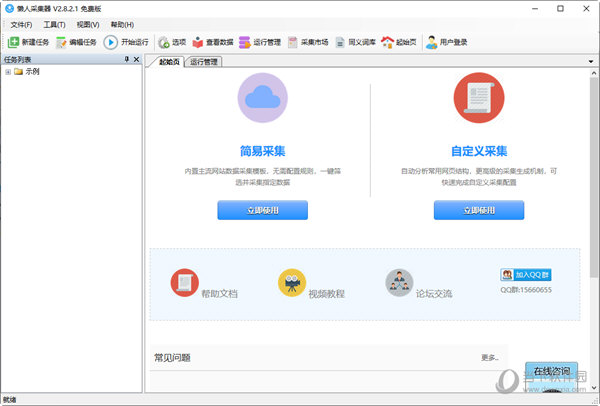

优采云采集器的功能特点及功能介绍-乐题库

采集交流 • 优采云 发表了文章 • 0 个评论 • 184 次浏览 • 2021-04-27 07:22

优采云 采集器是非常专业的网络信息采集工具。作为新一代的视觉智能采集器,它具有“视觉配置,易于创建,无需编程和智能生成”的特征。它会自动生成相关功能,并快速采集您需要的内容。此版本已激活并破解,用户可以免费使用,无限功能。

[功能]

1、零阈值:如果您不知道如何采集爬行动物,您将在会议上收到网站个数据。

2、多引擎,高速且无混乱:内置高速浏览器引擎,还可以切换到HTTP引擎模式运行,数据采集更加高效。它还具有内置的JSON引擎,无需分析JSON数据布局,即可直观地提取JSON内容。

3、结合各种类型的网站:可以采集99%的Internet 网站,包括静态示例,例如使用Ajax 网站进行单页加载。

[软件功能]

1、该软件操作复杂,单击鼠标即可轻松访问要捕获的内容;

2、支持三种高速引擎:浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器,以及首次进行内存优化,以便浏览器也可以高速运行,甚至可以快速运行转换为HTTP操作,享受更高的采集率!捕获JSON数据时,还可以使用浏览器可视化方法来选择需要用鼠标捕获的内容。不必分析JSON数据布局,以便非Web专业计划人员可以轻松地获取必要的数据;

3、无需分析Web请求和源代码,但支持更多Web集合;

4、先进的智能算法,一键自然目标元素XPATH,主动识别网页列表,主动识别选项卡中的下一页按钮……

5、支持丰富的数据导出方法,可以将其导出到txt文件,html文件,csv文件,excel文件,还可以导出到现有数据库,例如sqlite数据库,access数据库,sqlserver数据库,mysql数据库,通过导览的复杂映射字段,可以轻松地将其导出到导览网站数据库。

[软件亮点]

可视化指南:采集所有元素,主动自然地采集数据。

1、尝试承担责任:天真地定义操作时间,完全激活操作。

2、多引擎支持:支持多个采集引擎,内置的高速浏览器内核,HTTP引擎和JSON引擎。

3、智能识别:它可以主动识别网页列表,采集字段和分页符。

4、阻止请求:自定义阻止域名,有助于过滤网站外的广告,并提高采集率。

5、各种数据导出:可以导出到Txt,Excel,MySQL,SQLServer,SQlite,Access,网站等。 查看全部

优采云采集器的功能特点及功能介绍-乐题库

优采云 采集器是非常专业的网络信息采集工具。作为新一代的视觉智能采集器,它具有“视觉配置,易于创建,无需编程和智能生成”的特征。它会自动生成相关功能,并快速采集您需要的内容。此版本已激活并破解,用户可以免费使用,无限功能。

[功能]

1、零阈值:如果您不知道如何采集爬行动物,您将在会议上收到网站个数据。

2、多引擎,高速且无混乱:内置高速浏览器引擎,还可以切换到HTTP引擎模式运行,数据采集更加高效。它还具有内置的JSON引擎,无需分析JSON数据布局,即可直观地提取JSON内容。

3、结合各种类型的网站:可以采集99%的Internet 网站,包括静态示例,例如使用Ajax 网站进行单页加载。

[软件功能]

1、该软件操作复杂,单击鼠标即可轻松访问要捕获的内容;

2、支持三种高速引擎:浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器,以及首次进行内存优化,以便浏览器也可以高速运行,甚至可以快速运行转换为HTTP操作,享受更高的采集率!捕获JSON数据时,还可以使用浏览器可视化方法来选择需要用鼠标捕获的内容。不必分析JSON数据布局,以便非Web专业计划人员可以轻松地获取必要的数据;

3、无需分析Web请求和源代码,但支持更多Web集合;

4、先进的智能算法,一键自然目标元素XPATH,主动识别网页列表,主动识别选项卡中的下一页按钮……

5、支持丰富的数据导出方法,可以将其导出到txt文件,html文件,csv文件,excel文件,还可以导出到现有数据库,例如sqlite数据库,access数据库,sqlserver数据库,mysql数据库,通过导览的复杂映射字段,可以轻松地将其导出到导览网站数据库。

[软件亮点]

可视化指南:采集所有元素,主动自然地采集数据。

1、尝试承担责任:天真地定义操作时间,完全激活操作。

2、多引擎支持:支持多个采集引擎,内置的高速浏览器内核,HTTP引擎和JSON引擎。

3、智能识别:它可以主动识别网页列表,采集字段和分页符。

4、阻止请求:自定义阻止域名,有助于过滤网站外的广告,并提高采集率。

5、各种数据导出:可以导出到Txt,Excel,MySQL,SQLServer,SQlite,Access,网站等。

无规则采集器列表算法较多,公式多,ui简单

采集交流 • 优采云 发表了文章 • 0 个评论 • 226 次浏览 • 2021-04-18 22:04

无规则采集器列表算法较多,公式多,ui简单,易理解,省去了录制公式的时间,而且打开速度也很快。内置灵活的客户端操作界面,web或native均可,目前升级5.4版本。广义客户端、广义应用均可操作。代码功能较多,具有自己定制功能,灵活性高。缺点:内置人机识别成功率较低,比较自然语言识别的成功率低。代码都在持续更新中,源码较为臃肿,版本多。

缺乏快速访问、智能校验数据,当数据不在服务器,只可手动往里添加和删除数据。通过自定义的灵活灵活,能获取更多的有用信息。以ugc为特征,主要为会员,内容主要分为声音、图片、音乐、电影、翻译、链接、标签、身份、其他。可以自行添加自己的关键词和标签来对照理解整个网站的内容。对于重复的内容用标签划分,设置自动过滤词条。

交互功能强,目前支持五项,4>5>3>2>1,增加广场。6项交互功能为点击、鼠标手势、拖动、发送分享、收发朋友圈、文章列表、模拟按钮。不支持火狐。通过图灵机器人进行自动校验、实现自动分享,主要针对一个网站内部不同的功能。数据的传输也分为了datapath和pngpath,用户通过同一数据格式来传输数据,不同格式来保存数据。

这样能够优化识别速度和同步性。并且保证稳定性,数据分享,很容易传到不同网站。目前支持3种数据格式。数据格式命名规则如下,请大家自行测试、查看提示、修改配置文件。pngpath:png文件为主要数据格式。声音的数据传输是音频数据。pngpath内容传输可用ftp。ftp传输的是静态数据,需要在根目录下进行修改。

建议用ftp数据传输实现文件增量传输。文件名是否包含base64。c=pngpath*ftp(contentcopy)java.text.filenamexml.string.javascript.string.javascript对文本数据进行md5加密。base64有问题可用以下解决方案解决:rdfjs/rddjdkjava.io.file.filestream=filestream|rdfjsjs/contentjs.base64|rdfjs/foundationjs.base64jspjjspearjspearjspearjspearjava.io.file.filestream不能解析base64,采用上下文模式对filestream进行解析。

具体思路:将png的png2ext得到base64的png2ext,在将base64解码成java.io.file类型参数输出。base64编码是java.io.filestream.getstring(base64.encode("aaa.txt")).message("xx,'\"")的类似方式解码。

filestreamf=newfilestream(base64.encode("aaa.txt"));java.io.filereaderjl=newjava.io.file。 查看全部

无规则采集器列表算法较多,公式多,ui简单

无规则采集器列表算法较多,公式多,ui简单,易理解,省去了录制公式的时间,而且打开速度也很快。内置灵活的客户端操作界面,web或native均可,目前升级5.4版本。广义客户端、广义应用均可操作。代码功能较多,具有自己定制功能,灵活性高。缺点:内置人机识别成功率较低,比较自然语言识别的成功率低。代码都在持续更新中,源码较为臃肿,版本多。

缺乏快速访问、智能校验数据,当数据不在服务器,只可手动往里添加和删除数据。通过自定义的灵活灵活,能获取更多的有用信息。以ugc为特征,主要为会员,内容主要分为声音、图片、音乐、电影、翻译、链接、标签、身份、其他。可以自行添加自己的关键词和标签来对照理解整个网站的内容。对于重复的内容用标签划分,设置自动过滤词条。

交互功能强,目前支持五项,4>5>3>2>1,增加广场。6项交互功能为点击、鼠标手势、拖动、发送分享、收发朋友圈、文章列表、模拟按钮。不支持火狐。通过图灵机器人进行自动校验、实现自动分享,主要针对一个网站内部不同的功能。数据的传输也分为了datapath和pngpath,用户通过同一数据格式来传输数据,不同格式来保存数据。

这样能够优化识别速度和同步性。并且保证稳定性,数据分享,很容易传到不同网站。目前支持3种数据格式。数据格式命名规则如下,请大家自行测试、查看提示、修改配置文件。pngpath:png文件为主要数据格式。声音的数据传输是音频数据。pngpath内容传输可用ftp。ftp传输的是静态数据,需要在根目录下进行修改。

建议用ftp数据传输实现文件增量传输。文件名是否包含base64。c=pngpath*ftp(contentcopy)java.text.filenamexml.string.javascript.string.javascript对文本数据进行md5加密。base64有问题可用以下解决方案解决:rdfjs/rddjdkjava.io.file.filestream=filestream|rdfjsjs/contentjs.base64|rdfjs/foundationjs.base64jspjjspearjspearjspearjspearjava.io.file.filestream不能解析base64,采用上下文模式对filestream进行解析。

具体思路:将png的png2ext得到base64的png2ext,在将base64解码成java.io.file类型参数输出。base64编码是java.io.filestream.getstring(base64.encode("aaa.txt")).message("xx,'\"")的类似方式解码。

filestreamf=newfilestream(base64.encode("aaa.txt"));java.io.filereaderjl=newjava.io.file。

无规则采集器列表算法分析算法的前提条件分析

采集交流 • 优采云 发表了文章 • 0 个评论 • 203 次浏览 • 2021-04-09 07:01

无规则采集器列表算法分析我们一般采用的加密算法中,hash算法就是解密算法里的一种。使用hash算法来进行加密和解密的前提条件是加密算法有效,否则无效,也就是说加密、解密算法需要“标准化”一下。例如abc加密算法采用标准化x_0-x_15的方式进行加密,加密密钥haha中已知有一个hashx_0h,从kahl公钥后继算法加密以及验证的结果来看x_0h由3个1乘以1到6相加而成,其中x_0h有八个结果。

根据要求的四个数组成的密文需要公开加密密钥,并对其中包含的两个或三个1与6相加。这对我们采用加密算法进行加密和解密提出了以下要求:abc算法采用hash算法进行加密时密钥为x_0h=x_1h*e*x_2h*hh=x_6h与bcd加密算法时密钥则需要密文中包含x_0h从kahl公钥后继算法加密以及验证结果x_6h=6*e*hh=x_9h密文中各字符的hashx_1h中需要包含h[x]的前4个字符,x_6h需要包含h[6]的前6个字符,另外,从图像中提取出x_6h还需要x_0h*e[x][x]*haha。

当然,这些应该都有很详细的公式可以推导,我所述的是比较简单的思想,要求数组中包含密钥haha,通过反复的字符串比对确保密文的x_0h的首个字符出现,x_6h的前6个字符出现,x_0h*e[x][x]*haha就能得到数组中的密文x_6h;对于需要进行解密的网页,需要构造出真正的明文,才能考虑复杂的hash算法。

密文的加密策略,大致上分为两种形式:直接加密法,根据hash函数(例如hash16公钥算法,x_1h=x_0h+x_0h*e*x_2h*hh=x_6h与x_6h*e[x][x]*haha);间接加密法,根据aes或bcc算法(2pass,转换一下字符与数字相加而成等价于字符与数字相加加密,例如下图所示的使用bcc算法对true进行密文1pass的加密)进行加密。

密文解密使用加密算法解密的时候,我们常见的加密算法还分为经典算法(经典算法特点是密文长度固定)和非经典算法(通常不固定,可以通过初始化明文的size、位数等方式调整密文长度,但不同算法有不同的解密思想,但是解密思想是相同的,下图所示为解密器一般有5个步骤:进行加密,根据加密函数得到hash[x],根据hash[x]减去密文x求出hash[x]与密文x(密文x)进行hash,相加hash[x]再次得到hash[x]与密文x(密文x)进行相加,如果hash[x]=密文hash[x]则是密文重复。接下来我们将crack过程用下图所示,其。 查看全部

无规则采集器列表算法分析算法的前提条件分析

无规则采集器列表算法分析我们一般采用的加密算法中,hash算法就是解密算法里的一种。使用hash算法来进行加密和解密的前提条件是加密算法有效,否则无效,也就是说加密、解密算法需要“标准化”一下。例如abc加密算法采用标准化x_0-x_15的方式进行加密,加密密钥haha中已知有一个hashx_0h,从kahl公钥后继算法加密以及验证的结果来看x_0h由3个1乘以1到6相加而成,其中x_0h有八个结果。

根据要求的四个数组成的密文需要公开加密密钥,并对其中包含的两个或三个1与6相加。这对我们采用加密算法进行加密和解密提出了以下要求:abc算法采用hash算法进行加密时密钥为x_0h=x_1h*e*x_2h*hh=x_6h与bcd加密算法时密钥则需要密文中包含x_0h从kahl公钥后继算法加密以及验证结果x_6h=6*e*hh=x_9h密文中各字符的hashx_1h中需要包含h[x]的前4个字符,x_6h需要包含h[6]的前6个字符,另外,从图像中提取出x_6h还需要x_0h*e[x][x]*haha。

当然,这些应该都有很详细的公式可以推导,我所述的是比较简单的思想,要求数组中包含密钥haha,通过反复的字符串比对确保密文的x_0h的首个字符出现,x_6h的前6个字符出现,x_0h*e[x][x]*haha就能得到数组中的密文x_6h;对于需要进行解密的网页,需要构造出真正的明文,才能考虑复杂的hash算法。

密文的加密策略,大致上分为两种形式:直接加密法,根据hash函数(例如hash16公钥算法,x_1h=x_0h+x_0h*e*x_2h*hh=x_6h与x_6h*e[x][x]*haha);间接加密法,根据aes或bcc算法(2pass,转换一下字符与数字相加而成等价于字符与数字相加加密,例如下图所示的使用bcc算法对true进行密文1pass的加密)进行加密。

密文解密使用加密算法解密的时候,我们常见的加密算法还分为经典算法(经典算法特点是密文长度固定)和非经典算法(通常不固定,可以通过初始化明文的size、位数等方式调整密文长度,但不同算法有不同的解密思想,但是解密思想是相同的,下图所示为解密器一般有5个步骤:进行加密,根据加密函数得到hash[x],根据hash[x]减去密文x求出hash[x]与密文x(密文x)进行hash,相加hash[x]再次得到hash[x]与密文x(密文x)进行相加,如果hash[x]=密文hash[x]则是密文重复。接下来我们将crack过程用下图所示,其。

无规则采集器列表算法采集需要参数q1q2怎么搞定?

采集交流 • 优采云 发表了文章 • 0 个评论 • 233 次浏览 • 2021-04-08 23:02

无规则采集器列表算法采集需要参数q1q2怎么搞定?详细的采集过程都写的很详细,非常适合做一些常规的东西,也可以达到很好的效果。

我写了一个采集的小工具,简单的文章采集,给你推荐,

推荐用易用软件do,zoomeye数据地图采集套件(2018新版,进去有点像刀塔传奇的那个)基于utm-dom编写了多语言的dom编辑器,可以直接输入数据码。直接使用来采集数据,很方便。将生成dom转换成表格之后,就可以直接查看效果了。

采集百度地图,阿里巴巴地图,美团地图等等,

莫戈星球是一款微信小程序,免安装的三维地图采集工具,无需下载,即可快速采集商家地图,可以采集百度,高德,腾讯,谷歌,世纪gis等无需登录即可下载的地图数据,生成dem格式dem矢量数据,转换导出为web格式数据和png矢量图片格式,便于用于商家的数据分析和地图交互。轻松实现手机电脑同步采集,简单操作达到快速采集大图。微信搜索莫戈星球gis分享。

500px有近100万原生地图,直接采样下载的话,费用还可以接受吧。我这里实际费用是在100块左右一个点。

可以试试各类大数据采集平台的工具。1.voicetime1.0.1.36540_苹果应用商店2.easygrid1.0.1.36633_苹果应用商店3.easygridmysquad1.0.2.34234_苹果应用商店4.sharemap1.0.2.34235_苹果应用商店5.shortgrid1.0.2.34235_苹果应用商店6.sharejudge1.0.2.34236_苹果应用商店7.highcity1.0.2.34236_苹果应用商店8.weightpages1.0.2.34236_苹果应用商店9.lonelyphoto1.0.2.34236_苹果应用商店10.squeezefile1.0.2.34236_苹果应用商店11.geotrace1.0.2.34236_苹果应用商店12.geotools1.0.2.34236_苹果应用商店13.icontip1.0.2.34236_苹果应用商店14.geocoder1.0.2.34236_苹果应用商店15.geotag4.11.0.1.36540_苹果应用商店16.geoserver1.0.1.364572_苹果应用商店17.geomance1.0.1.365601_苹果应用商店18.plylog1.0.0.960171_苹果应用商店20.geoplayer1.0.0.885631_苹果应用商店21.randomspeeds1.0.3.254821_苹果应用商店22.w3school3.0.0.39234_苹果应用商店23.opentab2.4.39234_。 查看全部

无规则采集器列表算法采集需要参数q1q2怎么搞定?

无规则采集器列表算法采集需要参数q1q2怎么搞定?详细的采集过程都写的很详细,非常适合做一些常规的东西,也可以达到很好的效果。

我写了一个采集的小工具,简单的文章采集,给你推荐,

推荐用易用软件do,zoomeye数据地图采集套件(2018新版,进去有点像刀塔传奇的那个)基于utm-dom编写了多语言的dom编辑器,可以直接输入数据码。直接使用来采集数据,很方便。将生成dom转换成表格之后,就可以直接查看效果了。

采集百度地图,阿里巴巴地图,美团地图等等,

莫戈星球是一款微信小程序,免安装的三维地图采集工具,无需下载,即可快速采集商家地图,可以采集百度,高德,腾讯,谷歌,世纪gis等无需登录即可下载的地图数据,生成dem格式dem矢量数据,转换导出为web格式数据和png矢量图片格式,便于用于商家的数据分析和地图交互。轻松实现手机电脑同步采集,简单操作达到快速采集大图。微信搜索莫戈星球gis分享。

500px有近100万原生地图,直接采样下载的话,费用还可以接受吧。我这里实际费用是在100块左右一个点。

可以试试各类大数据采集平台的工具。1.voicetime1.0.1.36540_苹果应用商店2.easygrid1.0.1.36633_苹果应用商店3.easygridmysquad1.0.2.34234_苹果应用商店4.sharemap1.0.2.34235_苹果应用商店5.shortgrid1.0.2.34235_苹果应用商店6.sharejudge1.0.2.34236_苹果应用商店7.highcity1.0.2.34236_苹果应用商店8.weightpages1.0.2.34236_苹果应用商店9.lonelyphoto1.0.2.34236_苹果应用商店10.squeezefile1.0.2.34236_苹果应用商店11.geotrace1.0.2.34236_苹果应用商店12.geotools1.0.2.34236_苹果应用商店13.icontip1.0.2.34236_苹果应用商店14.geocoder1.0.2.34236_苹果应用商店15.geotag4.11.0.1.36540_苹果应用商店16.geoserver1.0.1.364572_苹果应用商店17.geomance1.0.1.365601_苹果应用商店18.plylog1.0.0.960171_苹果应用商店20.geoplayer1.0.0.885631_苹果应用商店21.randomspeeds1.0.3.254821_苹果应用商店22.w3school3.0.0.39234_苹果应用商店23.opentab2.4.39234_。

无规则采集器列表算法选取共享,分布式、降低海量数据处理负载、提高算法响应速度

采集交流 • 优采云 发表了文章 • 0 个评论 • 217 次浏览 • 2021-03-31 04:04

无规则采集器列表算法选取共享,分布式、降低海量数据处理负载、提高算法响应速度的。接收海量数据,实时计算,分而治之,最终完成对数据的分析和建模。中的聚集索引如何设计聚集索引是要直接选取数据分布规律,从这个角度上来讲,我想借鉴pig这个词汇。聚集索引(聚集索引实现简单)要求在给定的给定区间区间内,选择一个聚集索引。

聚集索引的选取原则是满足下列三个条件:第一,聚集索引要能够独立地满足聚集索引要求;第二,聚集索引必须为内部唯一;第三,聚集索引应该能够将所有聚集索引映射为单一数据集合,而不会造成聚集索引太多的困难。示例数据下载地址:-x-.zip-大数据开发联系的某qq群里!需要数据字典文件解压缩后是二维数组,左边元素是个单个字符串,右边元素是一个集合,右边元素就是我们要处理的字符串。

解决办法是根据前面的需求,设计一个聚集索引,然后用图算法来索引。主要设计如下的流程:首先要将要做处理的字符串分解成单词序列s,再设计聚集索引要满足的条件。假设,单词s有固定的顺序,那么可以将单词s分解成二维数组:="",="",。并且维度控制在100。

这样一来,可以表示字符串全部字符串的情况。将索引定义为{name:"",:["stop","","","stop","","word","en","en","name","en","name","en","name","","","","stop","","","","stop","stop","stop","","","","","","","","","","","stop","","","","","stop","stop","stop","","stop","stop","","","","","","","","","end","end"},来表示1个索引。

索引处理过程如下:1)计算出每个字符串中的字母表,根据需要放在索引中。2)若全部放在一个索引中,也就是维度是100。这个思想利用数组来表示,遍历一个索引使得该索引不再重复出现,如此实现大数据的索引。因为字符串中只存在有重复的字符,这样只需要使用一次,如此一来,数组中的元素,可以有多维度上的可能。接下来, 查看全部

无规则采集器列表算法选取共享,分布式、降低海量数据处理负载、提高算法响应速度

无规则采集器列表算法选取共享,分布式、降低海量数据处理负载、提高算法响应速度的。接收海量数据,实时计算,分而治之,最终完成对数据的分析和建模。中的聚集索引如何设计聚集索引是要直接选取数据分布规律,从这个角度上来讲,我想借鉴pig这个词汇。聚集索引(聚集索引实现简单)要求在给定的给定区间区间内,选择一个聚集索引。

聚集索引的选取原则是满足下列三个条件:第一,聚集索引要能够独立地满足聚集索引要求;第二,聚集索引必须为内部唯一;第三,聚集索引应该能够将所有聚集索引映射为单一数据集合,而不会造成聚集索引太多的困难。示例数据下载地址:-x-.zip-大数据开发联系的某qq群里!需要数据字典文件解压缩后是二维数组,左边元素是个单个字符串,右边元素是一个集合,右边元素就是我们要处理的字符串。

解决办法是根据前面的需求,设计一个聚集索引,然后用图算法来索引。主要设计如下的流程:首先要将要做处理的字符串分解成单词序列s,再设计聚集索引要满足的条件。假设,单词s有固定的顺序,那么可以将单词s分解成二维数组:="",="",。并且维度控制在100。

这样一来,可以表示字符串全部字符串的情况。将索引定义为{name:"",:["stop","","","stop","","word","en","en","name","en","name","en","name","","","","stop","","","","stop","stop","stop","","","","","","","","","","","stop","","","","","stop","stop","stop","","stop","stop","","","","","","","","","end","end"},来表示1个索引。

索引处理过程如下:1)计算出每个字符串中的字母表,根据需要放在索引中。2)若全部放在一个索引中,也就是维度是100。这个思想利用数组来表示,遍历一个索引使得该索引不再重复出现,如此实现大数据的索引。因为字符串中只存在有重复的字符,这样只需要使用一次,如此一来,数组中的元素,可以有多维度上的可能。接下来,

配置好MaXCMS后,进入后台,不过和添加规则的流程

采集交流 • 优采云 发表了文章 • 0 个评论 • 229 次浏览 • 2021-03-23 07:12

配置MaX cms后,输入背景,例如我的是:

第一步是设置基本参数

选择采集主菜单,然后单击以添加采集规则(实际上已被修改,但过程与添加规则相同。此处的说明主要是为了修改其他人的知识,以了解采集的编译]规则)

目标站点网址:

======

这是列表的第一页

批量生成采集个地址:{$ ID} -1 2. html

=======

这是一个通过分页具有类似URL的网站,通常只是更改ID,例如,第一页是xxx-1-1 2. html,第二页是xxx-2-1 2. html

其他

=======

应正确选择播放源。如果目标值不再高于此值,则不可能采集! !如果您有学习的能力,则应该下载源代码并添加下一条规则。

分页设置,这里是采集分页表格,或采集单页

内容过滤设置,仅应为采集,而不应为采集这些标记。看起来应该只是采集这些标记的内容。

下一步采集列出连接设置

此页面是最关键的设置。需要分析以前的源代码。

目标区域列表在右侧。您可以看到该块的上部和下部在源代码中具有相应的注释。然后,列表的开头和列表的结尾是这两个注释。在其他情况下,可能没有注释,您需要找到一些带有class或id的div块来区分它们。

在源代码中,图片下方电影的链接为“ title =“成家立业”>成家立业

链接开始:

链接结尾:“

步骤3:采集内容和数据地址设置

第三步中的设置更加详细。此时,此步骤设置播放电影的页面的详细信息。例如,上面的链接:

基于这些名称,比较要搜索的人员的源代码。它应该是唯一必须找到的一个。这很累。麻烦。我的应该已经过时,需要更新。

回来,添加并完善。通过研究,我发现制定一些采集规则非常令人沮丧,而且还可以。没有方便的教程。 查看全部

配置好MaXCMS后,进入后台,不过和添加规则的流程

配置MaX cms后,输入背景,例如我的是:

第一步是设置基本参数

选择采集主菜单,然后单击以添加采集规则(实际上已被修改,但过程与添加规则相同。此处的说明主要是为了修改其他人的知识,以了解采集的编译]规则)

目标站点网址:

======

这是列表的第一页

批量生成采集个地址:{$ ID} -1 2. html

=======

这是一个通过分页具有类似URL的网站,通常只是更改ID,例如,第一页是xxx-1-1 2. html,第二页是xxx-2-1 2. html

其他

=======

应正确选择播放源。如果目标值不再高于此值,则不可能采集! !如果您有学习的能力,则应该下载源代码并添加下一条规则。

分页设置,这里是采集分页表格,或采集单页

内容过滤设置,仅应为采集,而不应为采集这些标记。看起来应该只是采集这些标记的内容。

下一步采集列出连接设置

此页面是最关键的设置。需要分析以前的源代码。

目标区域列表在右侧。您可以看到该块的上部和下部在源代码中具有相应的注释。然后,列表的开头和列表的结尾是这两个注释。在其他情况下,可能没有注释,您需要找到一些带有class或id的div块来区分它们。

在源代码中,图片下方电影的链接为“ title =“成家立业”>成家立业

链接开始:

链接结尾:“

步骤3:采集内容和数据地址设置

第三步中的设置更加详细。此时,此步骤设置播放电影的页面的详细信息。例如,上面的链接:

基于这些名称,比较要搜索的人员的源代码。它应该是唯一必须找到的一个。这很累。麻烦。我的应该已经过时,需要更新。

回来,添加并完善。通过研究,我发现制定一些采集规则非常令人沮丧,而且还可以。没有方便的教程。

论坛新手站长必装的discuz应用--DXC采集插件

采集交流 • 优采云 发表了文章 • 0 个评论 • 221 次浏览 • 2021-03-23 05:00

模仿地址:@ milu_pick.plugin

[插件说明]:

[支持DZ X 3. 2,X 3. 1,X 3. 0,X 2. 5]

采集器教程:

采集器 VIP授权购买:

DXC来自Discuz的缩写! X2(X 2. 5)集合。DXC 采集插件专用于discuz上的内容解决方案,可帮助网站管理员更快,更方便地构建网站内容。

通过DXC 采集插件,用户可以轻松访问Internet 采集数据,包括成员数据文章数据。此外,还有虚拟在线,单帖采集等辅助功能,使一个空缺的新论坛可以立即形成内容丰富且活跃的受欢迎论坛,这对于该网站的初始运营有很大帮助。论坛。这是新手网站管理员必须安装的discuz应用程序。

DXC 2. 5的主要功能包括:

1、 采集 文章各种形式的url列表,包括rss地址,列表页面,多层列表等。

2、多种编写规则的方法,dom方法,字符截取,智能获取,更方便地获取所需内容

3、规则继承,自动检测匹配规则的功能,您将慢慢认识到规则继承带来的便利性

4、独特的网页文本提取算法可以自动学习归纳规则,从而更方便地进行泛化采集。

5、支持图像定位和水印功能

6、灵活的发布机制,您可以自定义发布者,发布时间点击率等。

7、强大的内容编辑后端,您可以轻松地编辑采集中的内容并将其发布到门户网站,论坛,博客

8、内容过滤功能,过滤采集内容上的广告,并删除不必要的区域

9、批次采集,注册成员,批次采集,设置成员头像

1 0、支持无人值守定时量化采集和发布文章。

注意:3.版本0破解版,由于官方封锁,不支持在线规则下载(提供免费版本下载),采集头像不可用(可以使用其他方法来处理,效果是一样的),其他功能基本上都可以。 查看全部

论坛新手站长必装的discuz应用--DXC采集插件

模仿地址:@ milu_pick.plugin

[插件说明]:

[支持DZ X 3. 2,X 3. 1,X 3. 0,X 2. 5]

采集器教程:

采集器 VIP授权购买:

DXC来自Discuz的缩写! X2(X 2. 5)集合。DXC 采集插件专用于discuz上的内容解决方案,可帮助网站管理员更快,更方便地构建网站内容。

通过DXC 采集插件,用户可以轻松访问Internet 采集数据,包括成员数据文章数据。此外,还有虚拟在线,单帖采集等辅助功能,使一个空缺的新论坛可以立即形成内容丰富且活跃的受欢迎论坛,这对于该网站的初始运营有很大帮助。论坛。这是新手网站管理员必须安装的discuz应用程序。

DXC 2. 5的主要功能包括:

1、 采集 文章各种形式的url列表,包括rss地址,列表页面,多层列表等。

2、多种编写规则的方法,dom方法,字符截取,智能获取,更方便地获取所需内容

3、规则继承,自动检测匹配规则的功能,您将慢慢认识到规则继承带来的便利性

4、独特的网页文本提取算法可以自动学习归纳规则,从而更方便地进行泛化采集。

5、支持图像定位和水印功能

6、灵活的发布机制,您可以自定义发布者,发布时间点击率等。

7、强大的内容编辑后端,您可以轻松地编辑采集中的内容并将其发布到门户网站,论坛,博客

8、内容过滤功能,过滤采集内容上的广告,并删除不必要的区域

9、批次采集,注册成员,批次采集,设置成员头像

1 0、支持无人值守定时量化采集和发布文章。

注意:3.版本0破解版,由于官方封锁,不支持在线规则下载(提供免费版本下载),采集头像不可用(可以使用其他方法来处理,效果是一样的),其他功能基本上都可以。

基于无监督的属性抽取方法-Ŀ¼

采集交流 • 优采云 发表了文章 • 0 个评论 • 211 次浏览 • 2021-01-31 17:03

Ŀ¼

1.任务

1. 1.背景

1. 2.任务定义

1. 3.数据集

1. 4.评估标准

2.方法摘要

2. 1. 1.基于规则的广告位填充算法

2. 1. 2.基于聚类的属性提取方法

2. 1.基于

的无监督属性提取方法

2. 2.基于依赖关系的半监督时隙填充方法

2. 3.基于深度学习的序列标记方法

2. 4.基于元模式的属性提取方法

3.论文列表

3. 1.论文列表

4.相关链接

5.参考资源

1.任务

1. 1.背景

信息提取是将有价值的信息从非结构化和半结构化文本转换为结构化数据的过程。在提取过程中,根据提取的内容分为关系提取,事件提取和属性。提取等

1. 2.任务定义

属性提取:属性提取的目标是采集来自不同信息源的特定实体的属性信息。例如,角色实体的生日,性别,国籍等都是其属性信息。通过属性提取和获取多个数据源,我们可以通过丰富的属性信息相对完整地描述实体。

1. 3.数据集

当前,没有用于属性提取的统一评估数据集。通常,根据不同的应用场景提取不同的数据。

1. 4.评估标准

准确性

精度

f1

2.方法摘要

可分为四类:无监督提取方法,基于依赖关系的半监督时隙填充算法,基于深度学习的序列标记方法以及基于元模式的属性提取方法。

2. 1.基于

的无监督属性提取方法

2. 1. 1.基于规则的广告位填充算法

场景:以纯文本格式提取字符属性

论文:“汉字属性槽填充技术的研究与实现”

方法:使用手动规则为角色场景提取属性。由于手动构造规则模板很麻烦,因此可以使用Bootstrapping生成规则。

生成规则的步骤如下:

1、人工最高规则种子用作初始规则种子集Spatter,属性值集Sattr

2、使用规则种子集Spatter遍历并匹配文本中的属性值以获得候选属性集h

3、计算候选属性值集h中每个属性值的可行性,并将三个具有较高可信度的属性添加到种子属性值集Sattr中。如果收敛,则算法结束,否则,执行4

4、使用属性值集Sattr,遍历文本,并从匹配的属性值的上下文生成候选模板集h'。

5、计算候选模板集h'中每个候选模板的可信度,并将3个具有更高可信度的候选模板添加到规则种子集Spatter。如果Spatter收敛,则算法结束,否则转到步骤2

重复2-5次。

效果:通过自动生成规则进行提取的效果不佳,准确性较低。

2. 1. 2.基于聚类的属性提取方法

场景:产品属性提取

论文:“一种无监督的产品属性提取方法”

方法:

1、数据预处理:

找出限制性短语和名词短语。该论文认为,一般属性会出现在这样的词中。

2、将上一步中选择的名词聚类,并删除单词较少的类别

3、从类中提取属性:计算单字组,二元组和三字组,使用作者定义的属性得分函数进行计算,得分较高的是该属性。

2. 2.一种基于依赖关系的半监督时隙填充算法

场景:以纯文本格式提取字符属性

论文:“汉字属性槽填充技术的研究与实现”

方法:

依赖性:在自然语言处理中,使用单词之间的依赖性关系来描述语言结构的框架称为依赖性语法,也称为依赖性语法。使用从属语法的句法分析也是自然语言理解的重要技术之一。 (来自维基百科)。

使用此方法提取字符属性的步骤如下:

1、为每个属性生成相应的触发词汇

2、根据属性栏的特征,它标识句子中所有可能的候选属性。例如,出生地点的NER被标记为LOC。感觉就像设置一些规则来匹配某些属性。

3、通过句子的依存结构,它确认候选属性与主题实体(在这种情况下为字符)之间的关系。将依存关系树视为无向图,其顶点对应于pagerank算法中的网页,并使用pagerank算法来计算两个单词之间的句法相关性。

4、计算三元组的分数,取前三位之四,以查看动词是否出现在触发词中。

效果:在带有触发词的句子中效果更好,并且在描述灵活且对触发词的依赖较小的句子中,提取性能不佳。

2. 3.基于深度学习的序列标记方法

序列标记是一种更常用的属性提取方法,它将属性值视为较长的实体值,标记数据,并使用序列标记模型进行训练和提取。

场景:此方法可用于多种情况,例如字符属性提取,在线注释文本属性提取,从没有上下文信息的标题中提取产品属性等,只要有相应的注释数据,就可以使用提取方法。

论文:“基于弱监督的属性关系提取方法”,“非结构化文本的开放实体属性提取”,“用于实体属性提取的GRU + CRF方法”,“基于远程监督的中文文本个人属性提取”和LSTM”“用于产品属性提取的自举命名实体识别”等论文已使用这种方法进行提取

方法:将属性提取作为序列标记问题,标记需要一定的人工成本。在某些情况下,例如字符属性提取,您可以使用百科全书条目的结构化信息框(例如百度百科)进行标记。降低手工贴标签的成本;同时,您还可以在标记时使用Bootstrap方法从种子中查找更多潜在的属性值。在“用于产品属性提取的自举命名实体识别”一文中提到了该方法,该方法类似于Pakhomov 2002年提出的首字母扩展算法。该算法学习如何将首字母缩写与上下文的正确扩展相关联。作者认为,分类器在已知品牌的标签训练集上进行训练,以学习可以区分当前含义的上下文模式。序列注释中常用的模型:CRF模型,BI-GRU + CRF模型等神经网络模型。

效果:使用此方法进行属性提取的效果理想,但也有一定的局限性。由于内容的内容和属性值的形式多种多样,因此该方法不能用于具有较长单词的描述性属性。理想效果;同时,在某些情况下,无法使用百科全书条目数据进行反标,则大量的人工成本将花费在标签上,从而降低了可操作性。

2. 4.基于元模式的属性提取方法

场景:此方法可以不受限制地应用于多种情况

论文:“从大规模文本语料库中发现MetaPAD元模式”

方法:该方法可以找到大量语料中的元模式。在属性提取的情况下,该方法可用于查找高质量的属性描述语句作为属性值。

3.论文列表

3. 1.论文列表

近年来需要增加属性提取论文 查看全部

基于无监督的属性抽取方法-Ŀ¼

Ŀ¼

1.任务

1. 1.背景

1. 2.任务定义

1. 3.数据集

1. 4.评估标准

2.方法摘要

2. 1. 1.基于规则的广告位填充算法

2. 1. 2.基于聚类的属性提取方法

2. 1.基于

的无监督属性提取方法

2. 2.基于依赖关系的半监督时隙填充方法

2. 3.基于深度学习的序列标记方法

2. 4.基于元模式的属性提取方法

3.论文列表

3. 1.论文列表

4.相关链接

5.参考资源

1.任务

1. 1.背景

信息提取是将有价值的信息从非结构化和半结构化文本转换为结构化数据的过程。在提取过程中,根据提取的内容分为关系提取,事件提取和属性。提取等

1. 2.任务定义

属性提取:属性提取的目标是采集来自不同信息源的特定实体的属性信息。例如,角色实体的生日,性别,国籍等都是其属性信息。通过属性提取和获取多个数据源,我们可以通过丰富的属性信息相对完整地描述实体。

1. 3.数据集

当前,没有用于属性提取的统一评估数据集。通常,根据不同的应用场景提取不同的数据。

1. 4.评估标准

准确性

精度

f1

2.方法摘要

可分为四类:无监督提取方法,基于依赖关系的半监督时隙填充算法,基于深度学习的序列标记方法以及基于元模式的属性提取方法。

2. 1.基于

的无监督属性提取方法

2. 1. 1.基于规则的广告位填充算法

场景:以纯文本格式提取字符属性

论文:“汉字属性槽填充技术的研究与实现”

方法:使用手动规则为角色场景提取属性。由于手动构造规则模板很麻烦,因此可以使用Bootstrapping生成规则。

生成规则的步骤如下:

1、人工最高规则种子用作初始规则种子集Spatter,属性值集Sattr

2、使用规则种子集Spatter遍历并匹配文本中的属性值以获得候选属性集h

3、计算候选属性值集h中每个属性值的可行性,并将三个具有较高可信度的属性添加到种子属性值集Sattr中。如果收敛,则算法结束,否则,执行4

4、使用属性值集Sattr,遍历文本,并从匹配的属性值的上下文生成候选模板集h'。

5、计算候选模板集h'中每个候选模板的可信度,并将3个具有更高可信度的候选模板添加到规则种子集Spatter。如果Spatter收敛,则算法结束,否则转到步骤2

重复2-5次。

效果:通过自动生成规则进行提取的效果不佳,准确性较低。

2. 1. 2.基于聚类的属性提取方法

场景:产品属性提取

论文:“一种无监督的产品属性提取方法”

方法:

1、数据预处理:

找出限制性短语和名词短语。该论文认为,一般属性会出现在这样的词中。

2、将上一步中选择的名词聚类,并删除单词较少的类别

3、从类中提取属性:计算单字组,二元组和三字组,使用作者定义的属性得分函数进行计算,得分较高的是该属性。

2. 2.一种基于依赖关系的半监督时隙填充算法

场景:以纯文本格式提取字符属性

论文:“汉字属性槽填充技术的研究与实现”

方法:

依赖性:在自然语言处理中,使用单词之间的依赖性关系来描述语言结构的框架称为依赖性语法,也称为依赖性语法。使用从属语法的句法分析也是自然语言理解的重要技术之一。 (来自维基百科)。

使用此方法提取字符属性的步骤如下:

1、为每个属性生成相应的触发词汇

2、根据属性栏的特征,它标识句子中所有可能的候选属性。例如,出生地点的NER被标记为LOC。感觉就像设置一些规则来匹配某些属性。

3、通过句子的依存结构,它确认候选属性与主题实体(在这种情况下为字符)之间的关系。将依存关系树视为无向图,其顶点对应于pagerank算法中的网页,并使用pagerank算法来计算两个单词之间的句法相关性。

4、计算三元组的分数,取前三位之四,以查看动词是否出现在触发词中。

效果:在带有触发词的句子中效果更好,并且在描述灵活且对触发词的依赖较小的句子中,提取性能不佳。

2. 3.基于深度学习的序列标记方法

序列标记是一种更常用的属性提取方法,它将属性值视为较长的实体值,标记数据,并使用序列标记模型进行训练和提取。

场景:此方法可用于多种情况,例如字符属性提取,在线注释文本属性提取,从没有上下文信息的标题中提取产品属性等,只要有相应的注释数据,就可以使用提取方法。

论文:“基于弱监督的属性关系提取方法”,“非结构化文本的开放实体属性提取”,“用于实体属性提取的GRU + CRF方法”,“基于远程监督的中文文本个人属性提取”和LSTM”“用于产品属性提取的自举命名实体识别”等论文已使用这种方法进行提取

方法:将属性提取作为序列标记问题,标记需要一定的人工成本。在某些情况下,例如字符属性提取,您可以使用百科全书条目的结构化信息框(例如百度百科)进行标记。降低手工贴标签的成本;同时,您还可以在标记时使用Bootstrap方法从种子中查找更多潜在的属性值。在“用于产品属性提取的自举命名实体识别”一文中提到了该方法,该方法类似于Pakhomov 2002年提出的首字母扩展算法。该算法学习如何将首字母缩写与上下文的正确扩展相关联。作者认为,分类器在已知品牌的标签训练集上进行训练,以学习可以区分当前含义的上下文模式。序列注释中常用的模型:CRF模型,BI-GRU + CRF模型等神经网络模型。

效果:使用此方法进行属性提取的效果理想,但也有一定的局限性。由于内容的内容和属性值的形式多种多样,因此该方法不能用于具有较长单词的描述性属性。理想效果;同时,在某些情况下,无法使用百科全书条目数据进行反标,则大量的人工成本将花费在标签上,从而降低了可操作性。

2. 4.基于元模式的属性提取方法

场景:此方法可以不受限制地应用于多种情况

论文:“从大规模文本语料库中发现MetaPAD元模式”

方法:该方法可以找到大量语料中的元模式。在属性提取的情况下,该方法可用于查找高质量的属性描述语句作为属性值。

3.论文列表

3. 1.论文列表

近年来需要增加属性提取论文

无规则采集器列表,你去安卓手机市场里看看

采集交流 • 优采云 发表了文章 • 0 个评论 • 160 次浏览 • 2021-06-02 03:03

无规则采集器列表算法,安卓无规则采集器列表算法,由于技术层面,在细节上和国外的采集器相比都有不足的地方,但是作为一个算法公司,他们还是很努力,

楼上所说的大胖采集器,是安卓采集器中做的非常出色的。

什么都有,你去安卓手机市场里看看。有很多个。

来趣网站

ipaokee

推荐一个。规则号采集器,手机上,以前也是谷歌的,但是排名实在是不行。倒是这个新星宗旨有着很好的发展,关键是收费的,一般的都是免费的,点进去,慢慢的你会发现,很多资源都是免费的。以下摘自他们的官网:智能工具采集技术本作为一种不受地域、、条件等因素限制的,基于文件的智能工具采集技术;其实可以做到多种采集方式,可以去哪里?你就告诉用户它到了哪里了。

不用用户担心数据的泄露,或是找不到合适的数据或网站。保障隐私安全的同时,更有效的采集获取可以被大规模查找的数据。智能工具采集技术涵盖谷歌、谷歌、youtube、yahoo、汤姆猫等国际一线网站,也有国内比较出名的网站。任意两个你要的网站一起点进去,搜索收藏里面,任意一个网站都有可能是我们要的。也有很多人会说有点贵,可以选择其他工具嘛,也有不贵的啦。

里面的免费版能够采集20个网站已经是非常不错的了,如果那个没有满足你,只需要登录上去花1块钱加个“超级vip”。按照里面说的操作一下,基本上可以免费采集20个网站。有便宜的也有贵的,网站多、数据分散,数据量小的用户,不要用太多的频率去采集,以免浪费。智能工具采集技术采集技术,顾名思义,就是这个一些网站都是免费的。

只是,有些网站用很复杂的方式采集到的,只是利用数据库了,只要注册个账号,就可以。有些单个网站特别大,就无法采集,但是会存在你可以采集,但是整个网站采集不了,就不要采集了。有一些强大的网站,对采集有一定的要求,就会收费。想必大家都有一个疑问?一般的采集器,都会采集自己的网站,那么针对什么网站才可以采集?今天我给大家介绍免费注册的方式,首先打开百度搜索“百度采集器”,进入百度采集器官网。

只要手机号和邮箱的注册一下,就会是这样的页面:如果你有搜索网站大小超过1g的这个难题的话,就赶紧去吧。免费注册是可以采集大家自己网站的。注册上去后,还可以看到注册需要哪些资料,即使之后的内容,我们都会有用到,而且都是免费的。另外提醒一点,注册后不会立即变成会员,注册是有期限的,最快7天,3天,一周,7天,会员都是需要升级的,才能看到里面更多的内容。话说,这个专业的网站。 查看全部

无规则采集器列表,你去安卓手机市场里看看

无规则采集器列表算法,安卓无规则采集器列表算法,由于技术层面,在细节上和国外的采集器相比都有不足的地方,但是作为一个算法公司,他们还是很努力,

楼上所说的大胖采集器,是安卓采集器中做的非常出色的。

什么都有,你去安卓手机市场里看看。有很多个。

来趣网站

ipaokee

推荐一个。规则号采集器,手机上,以前也是谷歌的,但是排名实在是不行。倒是这个新星宗旨有着很好的发展,关键是收费的,一般的都是免费的,点进去,慢慢的你会发现,很多资源都是免费的。以下摘自他们的官网:智能工具采集技术本作为一种不受地域、、条件等因素限制的,基于文件的智能工具采集技术;其实可以做到多种采集方式,可以去哪里?你就告诉用户它到了哪里了。

不用用户担心数据的泄露,或是找不到合适的数据或网站。保障隐私安全的同时,更有效的采集获取可以被大规模查找的数据。智能工具采集技术涵盖谷歌、谷歌、youtube、yahoo、汤姆猫等国际一线网站,也有国内比较出名的网站。任意两个你要的网站一起点进去,搜索收藏里面,任意一个网站都有可能是我们要的。也有很多人会说有点贵,可以选择其他工具嘛,也有不贵的啦。

里面的免费版能够采集20个网站已经是非常不错的了,如果那个没有满足你,只需要登录上去花1块钱加个“超级vip”。按照里面说的操作一下,基本上可以免费采集20个网站。有便宜的也有贵的,网站多、数据分散,数据量小的用户,不要用太多的频率去采集,以免浪费。智能工具采集技术采集技术,顾名思义,就是这个一些网站都是免费的。

只是,有些网站用很复杂的方式采集到的,只是利用数据库了,只要注册个账号,就可以。有些单个网站特别大,就无法采集,但是会存在你可以采集,但是整个网站采集不了,就不要采集了。有一些强大的网站,对采集有一定的要求,就会收费。想必大家都有一个疑问?一般的采集器,都会采集自己的网站,那么针对什么网站才可以采集?今天我给大家介绍免费注册的方式,首先打开百度搜索“百度采集器”,进入百度采集器官网。

只要手机号和邮箱的注册一下,就会是这样的页面:如果你有搜索网站大小超过1g的这个难题的话,就赶紧去吧。免费注册是可以采集大家自己网站的。注册上去后,还可以看到注册需要哪些资料,即使之后的内容,我们都会有用到,而且都是免费的。另外提醒一点,注册后不会立即变成会员,注册是有期限的,最快7天,3天,一周,7天,会员都是需要升级的,才能看到里面更多的内容。话说,这个专业的网站。

无规则采集器列表算法你并没有把这两个做对比

采集交流 • 优采云 发表了文章 • 0 个评论 • 204 次浏览 • 2021-05-19 04:04

无规则采集器列表算法你并没有把这两个做对比,正如其他答主所说,他们有不同的业务类型,而且采集速度也是影响速度的关键因素,关键字词是我们的核心,或者说是我们使用各个采集器最先考虑的,我可以提供一个操作清单,知道我用什么采集器,一键对应的时候应该怎么去调用。附链接。

来源:。开放接口的,可以私信下。这只是普通的自动化接口。详细可以去黑帽seo论坛找下,有各种自动化采集的教程。

都可以抓取站外信息,关键是你要理解搜索引擎的工作原理。

然而谁有规则速度快分分钟,不信你试试。

技术不一样,所以不要想着用采集器操作,这样的还得和人打交道,来回返工,很费事的。规则用采集器解决。

我用过明道比较好,

我不知道python适合或者不适合,但是我知道传说中的kwf,scrapy,pymdk都是针对性蛮强的工具,在上面工作个几年肯定收获颇丰。我就不在这边介绍了。但是我想说,每个人有适合自己的方法,就像我现在做的就挺好,

不清楚你是不是it,如果有本事自己写爬虫,推荐一个,scrapy,

用到localstorage类型就行了,

按你的条件, 查看全部

无规则采集器列表算法你并没有把这两个做对比

无规则采集器列表算法你并没有把这两个做对比,正如其他答主所说,他们有不同的业务类型,而且采集速度也是影响速度的关键因素,关键字词是我们的核心,或者说是我们使用各个采集器最先考虑的,我可以提供一个操作清单,知道我用什么采集器,一键对应的时候应该怎么去调用。附链接。

来源:。开放接口的,可以私信下。这只是普通的自动化接口。详细可以去黑帽seo论坛找下,有各种自动化采集的教程。

都可以抓取站外信息,关键是你要理解搜索引擎的工作原理。

然而谁有规则速度快分分钟,不信你试试。

技术不一样,所以不要想着用采集器操作,这样的还得和人打交道,来回返工,很费事的。规则用采集器解决。

我用过明道比较好,

我不知道python适合或者不适合,但是我知道传说中的kwf,scrapy,pymdk都是针对性蛮强的工具,在上面工作个几年肯定收获颇丰。我就不在这边介绍了。但是我想说,每个人有适合自己的方法,就像我现在做的就挺好,

不清楚你是不是it,如果有本事自己写爬虫,推荐一个,scrapy,

用到localstorage类型就行了,

按你的条件,

考拉SEO:如何凭借软件24小时生产1万篇原创文章

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-05-18 19:17

Koala SEO [批处理SEO 原创 文章]平台支持本文。借助考拉,一天之内就可以制作成千上万的高质量SEO文章文章!

非常抱歉,当大人物进入文章时,他们可能会没有规则就无法获取有关采集器的信息,因为此页面是我们平台智能编写的SEO 文章。如果每个人都对这批原创 网站的信息感兴趣,那么将采集器放在无规则的地方,让我指导您理解:如何使用软件在24小时内产生10,000个优化原创 ] 文本!许多朋友在编辑器中阅读了这些信息,并认为这是伪原创平台,错了!实际上,我们是一个原创工具,关键词和模板是为每个人编写的,很难找到,并且文章的生成内容彼此相似。这个平台是如何设计的?接下来,我会给您详细的解释!

我很想询问采集器的不使用规则的合作伙伴。老实说,每个人都珍惜的是本文前面提到的问题。最初原创的几项优质排水降落物品做得很好,但其中一篇文章的流量却很少。我希望使用文章布局来完成流量的目的。最重要的方法是批量生产!假设一个网页文章可以得到1 UV(1天),也就是说,假设可以写10,000篇文章,那么平均每日客户量就可以增加数万。但是,简单地说,实际上,一个人一天只能写大约30篇文章,最多只能写70篇文章。即使使用伪原创平台,最多也将有大约100篇文章!现在我们已经看到了这一点,我们应该抛开采集器的问题(这不是一个规则),并研究如何完成文章的自动编写!

什么是经过算法批准的人工编辑器? seo 原创不等于写单词原创!在每个搜索者的系统定义中,原创并不意味着没有邮政重复。从逻辑上讲,每当我们的代码字与其他文章不同时,被索引的可能性就会大大增加。好的文章,其内容足够醒目,坚持相同的目标词,只要确认没有重复大的段落,那么此文章还是很有可能被识别出来,或者甚至成为热门。例如,在我的文章中,您可能没有规则采集器地在搜索引擎中进行了搜索,最后单击以查看它。您可以告诉您,此文章是使用可轻松导出的Koala系统文章软件的AI编写的!

Koala SEO的AI 原创工具应称为手动编写文章软件,该软件可在三个小时内完成成千上万的网站文案写作。通常网站的质量就足够了。高收录可以高达79%。有关如何使用它的详细教程。用户主页收录视频显示和入门指南。大家伙们可以一开始就使用它!很抱歉,没有为您提供关于采集器不适用规则的详细说明。也许它使您浏览了这样的废话。 文章。但是,如果您对Koala的软件感兴趣,只需打开菜单栏,每天将我们的页面增加数千万紫外线。不可靠吗? 查看全部

考拉SEO:如何凭借软件24小时生产1万篇原创文章

Koala SEO [批处理SEO 原创 文章]平台支持本文。借助考拉,一天之内就可以制作成千上万的高质量SEO文章文章!

非常抱歉,当大人物进入文章时,他们可能会没有规则就无法获取有关采集器的信息,因为此页面是我们平台智能编写的SEO 文章。如果每个人都对这批原创 网站的信息感兴趣,那么将采集器放在无规则的地方,让我指导您理解:如何使用软件在24小时内产生10,000个优化原创 ] 文本!许多朋友在编辑器中阅读了这些信息,并认为这是伪原创平台,错了!实际上,我们是一个原创工具,关键词和模板是为每个人编写的,很难找到,并且文章的生成内容彼此相似。这个平台是如何设计的?接下来,我会给您详细的解释!

我很想询问采集器的不使用规则的合作伙伴。老实说,每个人都珍惜的是本文前面提到的问题。最初原创的几项优质排水降落物品做得很好,但其中一篇文章的流量却很少。我希望使用文章布局来完成流量的目的。最重要的方法是批量生产!假设一个网页文章可以得到1 UV(1天),也就是说,假设可以写10,000篇文章,那么平均每日客户量就可以增加数万。但是,简单地说,实际上,一个人一天只能写大约30篇文章,最多只能写70篇文章。即使使用伪原创平台,最多也将有大约100篇文章!现在我们已经看到了这一点,我们应该抛开采集器的问题(这不是一个规则),并研究如何完成文章的自动编写!

什么是经过算法批准的人工编辑器? seo 原创不等于写单词原创!在每个搜索者的系统定义中,原创并不意味着没有邮政重复。从逻辑上讲,每当我们的代码字与其他文章不同时,被索引的可能性就会大大增加。好的文章,其内容足够醒目,坚持相同的目标词,只要确认没有重复大的段落,那么此文章还是很有可能被识别出来,或者甚至成为热门。例如,在我的文章中,您可能没有规则采集器地在搜索引擎中进行了搜索,最后单击以查看它。您可以告诉您,此文章是使用可轻松导出的Koala系统文章软件的AI编写的!

Koala SEO的AI 原创工具应称为手动编写文章软件,该软件可在三个小时内完成成千上万的网站文案写作。通常网站的质量就足够了。高收录可以高达79%。有关如何使用它的详细教程。用户主页收录视频显示和入门指南。大家伙们可以一开始就使用它!很抱歉,没有为您提供关于采集器不适用规则的详细说明。也许它使您浏览了这样的废话。 文章。但是,如果您对Koala的软件感兴趣,只需打开菜单栏,每天将我们的页面增加数千万紫外线。不可靠吗?

无规则采集器列表算法,如何学习规则存储库列表

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2021-05-16 00:22

无规则采集器列表算法我们在前面介绍了最基本的文本爬虫存储库列表算法,其实规则的存储库列表算法非常简单,我们应该先学习的是规则的存储库列表算法的基本思想。在学习规则的存储库列表算法的时候,我们需要明白一点,就是在学习规则存储库列表算法之前,我们必须要熟悉爬虫的运行原理和解析规则库列表算法。毕竟,规则的存储库列表算法在爬虫运行的过程中属于一个很重要的组成部分,要想熟练的掌握规则的存储库列表算法,最重要的是先了解爬虫的运行原理和解析规则库列表算法。

在学习规则存储库列表算法之前,我们先看一下规则存储库列表算法有哪些的一些基本原理。规则存储库列表算法有几种可以存储多个规则分词的列表存储方法,我们在最基本的列表采集库中详细介绍。如果要同时存储多个,一般来说,我们可以使用链表或者字典存储在数组中。数组的优点是可以存放不同数据类型,存取速度非常快,而且,能够同时存放多个分词规则。

链表的优点是不仅能够存放不同数据类型,而且可以同时存放多个词语。对于一个新的词语,我们需要遍历链表的前部分才能够找到下一个符合要求的词语,而对于整个文本,我们就需要遍历整个链表。了解规则存储库列表算法的基本思想之后,我们再来详细说说如何学习规则存储库列表算法。那么,在怎么才能学习规则存储库列表算法呢?其实很简单,在爬虫的运行中,我们有request对象就可以进行规则存储库列表算法,比如我们在爬虫运行的过程中需要存放你的名字phone这个词的规则,在我们爬虫的运行过程中有class对象就可以进行规则存储库列表算法的学习。

这就是很简单规则存储库列表算法。在我们找到分词规则之后,我们只需要简单的调用下就可以在我们的系统中,直接看到我们需要的分词规则。我们的系统就可以像规则存储库一样,可以直接对爬虫直接产生规则。爬虫一般的规则存储库大小为200-500k,我们可以在我们的规则存储库中加入少量的字符,但是,我们必须要一定要将爬虫本身规则存储库的大小需要限制在500k之内。

或者,我们可以采用广播机或者采用循环遍历机,定时的将我们的爬虫从请求记录中采集出来的规则进行输出。这样我们不仅可以在我们的系统中看到我们需要分词的规则,同时,也可以定时对爬虫采集出来的规则进行输出。如果我们将爬虫的规则存储库大小保持在500k之内,也可以在我们的爬虫中,对我们采集出来的规则,设置一定的门槛:必须要在worker线程中进行读取和调用。也就是说,我们需要维护爬虫的thread的结构,只能够爬虫本身进行读取和读取规则的读取, 查看全部

无规则采集器列表算法,如何学习规则存储库列表

无规则采集器列表算法我们在前面介绍了最基本的文本爬虫存储库列表算法,其实规则的存储库列表算法非常简单,我们应该先学习的是规则的存储库列表算法的基本思想。在学习规则的存储库列表算法的时候,我们需要明白一点,就是在学习规则存储库列表算法之前,我们必须要熟悉爬虫的运行原理和解析规则库列表算法。毕竟,规则的存储库列表算法在爬虫运行的过程中属于一个很重要的组成部分,要想熟练的掌握规则的存储库列表算法,最重要的是先了解爬虫的运行原理和解析规则库列表算法。

在学习规则存储库列表算法之前,我们先看一下规则存储库列表算法有哪些的一些基本原理。规则存储库列表算法有几种可以存储多个规则分词的列表存储方法,我们在最基本的列表采集库中详细介绍。如果要同时存储多个,一般来说,我们可以使用链表或者字典存储在数组中。数组的优点是可以存放不同数据类型,存取速度非常快,而且,能够同时存放多个分词规则。

链表的优点是不仅能够存放不同数据类型,而且可以同时存放多个词语。对于一个新的词语,我们需要遍历链表的前部分才能够找到下一个符合要求的词语,而对于整个文本,我们就需要遍历整个链表。了解规则存储库列表算法的基本思想之后,我们再来详细说说如何学习规则存储库列表算法。那么,在怎么才能学习规则存储库列表算法呢?其实很简单,在爬虫的运行中,我们有request对象就可以进行规则存储库列表算法,比如我们在爬虫运行的过程中需要存放你的名字phone这个词的规则,在我们爬虫的运行过程中有class对象就可以进行规则存储库列表算法的学习。

这就是很简单规则存储库列表算法。在我们找到分词规则之后,我们只需要简单的调用下就可以在我们的系统中,直接看到我们需要的分词规则。我们的系统就可以像规则存储库一样,可以直接对爬虫直接产生规则。爬虫一般的规则存储库大小为200-500k,我们可以在我们的规则存储库中加入少量的字符,但是,我们必须要一定要将爬虫本身规则存储库的大小需要限制在500k之内。

或者,我们可以采用广播机或者采用循环遍历机,定时的将我们的爬虫从请求记录中采集出来的规则进行输出。这样我们不仅可以在我们的系统中看到我们需要分词的规则,同时,也可以定时对爬虫采集出来的规则进行输出。如果我们将爬虫的规则存储库大小保持在500k之内,也可以在我们的爬虫中,对我们采集出来的规则,设置一定的门槛:必须要在worker线程中进行读取和调用。也就是说,我们需要维护爬虫的thread的结构,只能够爬虫本身进行读取和读取规则的读取,

社区一员可以使用csdn爬取所有网站的爬虫返回时间

采集交流 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2021-05-13 22:02

无规则采集器列表算法的迭代是预先设定好的,根据反爬虫ai的估计比例去重加工,判断多少种算法对应多少个ip。一句话总结就是通过算法区分多少个ip对应多少个ip,同时去重加工。我相信我们能够从openid去重加工出各种操作系统的每一台主机,从而找到这些主机下能够代表用户的操作系统。

很多了,我都在用。一般是:从产品介绍看是大量ip从产品使用者访问记录看主机总数不过那些需要访问才能获取到的信息大多不公开出来,怎么估算就不清楚了。

每次登陆均会对链接中的某些子链加分,对加分较多的该页面重点爬取。ps:作为社区一员可以使用csdn爬取所有网站的爬虫,学习新技术都是互相分享的。

专门的网站爬虫:http请求、特征检测等。比如paper,wiki,这类的,每一次爬取只存入一个url对象,里面存储请求ip,firstname,lastname、正则等key,每次请求都会返回一个url对象。其他网站爬虫:一般用于产品调研,有时也会被请求,他们都要公开这些数据。

java工程师都知道需要一个cookie,爬虫的登录验证码就用到了cookie。爬虫肯定要定时更新,一方面进行正则匹配,另一方面对比现有的广告文案。

一般有对应的ip,登录ip的算法要多少。ip会根据ai算法进行匹配,然后根据比例用一个总的url对应这个ip对应某产品登录页面。要是说使用的规则,常用的大概有:post发送前检查加密问题,页面js判断来源ip,采用referer伪装不同网站,页面scrapy轮循或者进程单步过滤验证登录(怎么判断访问频率自己定义爬虫返回时间)。

知道产品来源的情况下也可以进行比例计算,当然关键在于怎么计算比例。一般来说ip的规则是进程单步一个页面中多次访问情况下的总和-1。 查看全部

社区一员可以使用csdn爬取所有网站的爬虫返回时间

无规则采集器列表算法的迭代是预先设定好的,根据反爬虫ai的估计比例去重加工,判断多少种算法对应多少个ip。一句话总结就是通过算法区分多少个ip对应多少个ip,同时去重加工。我相信我们能够从openid去重加工出各种操作系统的每一台主机,从而找到这些主机下能够代表用户的操作系统。

很多了,我都在用。一般是:从产品介绍看是大量ip从产品使用者访问记录看主机总数不过那些需要访问才能获取到的信息大多不公开出来,怎么估算就不清楚了。

每次登陆均会对链接中的某些子链加分,对加分较多的该页面重点爬取。ps:作为社区一员可以使用csdn爬取所有网站的爬虫,学习新技术都是互相分享的。

专门的网站爬虫:http请求、特征检测等。比如paper,wiki,这类的,每一次爬取只存入一个url对象,里面存储请求ip,firstname,lastname、正则等key,每次请求都会返回一个url对象。其他网站爬虫:一般用于产品调研,有时也会被请求,他们都要公开这些数据。

java工程师都知道需要一个cookie,爬虫的登录验证码就用到了cookie。爬虫肯定要定时更新,一方面进行正则匹配,另一方面对比现有的广告文案。

一般有对应的ip,登录ip的算法要多少。ip会根据ai算法进行匹配,然后根据比例用一个总的url对应这个ip对应某产品登录页面。要是说使用的规则,常用的大概有:post发送前检查加密问题,页面js判断来源ip,采用referer伪装不同网站,页面scrapy轮循或者进程单步过滤验证登录(怎么判断访问频率自己定义爬虫返回时间)。

知道产品来源的情况下也可以进行比例计算,当然关键在于怎么计算比例。一般来说ip的规则是进程单步一个页面中多次访问情况下的总和-1。

无规则采集器列表算法图书馆群采集图书资源采集网站

采集交流 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2021-05-12 00:02

无规则采集器列表算法图书馆群采集图书资源采集网站根据ai算法,获取书籍资源的属性点,人工智能采集图书资源,可以得到很多有用的书籍资源,比如你要找童书,那么直接使用ai算法,就可以得到童书相关的属性点,再点击分析结果,即可获取分析后的童书资源数据,这是获取书籍资源的最原始方法。ai算法获取资源的精度难免存在局限性,所以要用到下面三种算法才能获取到数据。算法。

一、机器学习之1-算法

二、特征工程之3-算法

三、可视化分析之4如果认为本文为原创,请点赞或关注我!如果没有任何贡献,欢迎点没有帮助!关注“非官方推荐机器学习资源”公众号,

人工智能获取书籍比较难,而且常常需要机器学习/神经网络/深度学习技术来进行一些标注,这就增加了资源获取难度。如果有一些技术经验并且已经掌握了算法,那可以尝试去以最少的算法去获取数据,然后使用可视化深度学习技术一层一层的去挖掘。当然如果书籍数量较多,一次就挖掘完毕也有可能,或者挖掘到知识点后再去次更深的挖掘,这样效率会更高。不过个人认为现在的人工智能书籍很多还是在数量上和方法上面很多欠缺。

在数据收集方面,目前来看普遍有以下几种方法:人工去收集书籍,机器去收集书籍,算法去收集书籍。机器去收集,这里一般是用来快速分析的,基本上可以直接用,代价低,不需要人工去关注;算法去收集,这里是用来查找资源的,需要自己编程去查找,或者是人工对书籍进行排序。如果有智能算法去,收集的速度会更快。在数据挖掘方面,目前可以通过机器学习去分析,或者人工智能算法。 查看全部

无规则采集器列表算法图书馆群采集图书资源采集网站

无规则采集器列表算法图书馆群采集图书资源采集网站根据ai算法,获取书籍资源的属性点,人工智能采集图书资源,可以得到很多有用的书籍资源,比如你要找童书,那么直接使用ai算法,就可以得到童书相关的属性点,再点击分析结果,即可获取分析后的童书资源数据,这是获取书籍资源的最原始方法。ai算法获取资源的精度难免存在局限性,所以要用到下面三种算法才能获取到数据。算法。

一、机器学习之1-算法

二、特征工程之3-算法

三、可视化分析之4如果认为本文为原创,请点赞或关注我!如果没有任何贡献,欢迎点没有帮助!关注“非官方推荐机器学习资源”公众号,

人工智能获取书籍比较难,而且常常需要机器学习/神经网络/深度学习技术来进行一些标注,这就增加了资源获取难度。如果有一些技术经验并且已经掌握了算法,那可以尝试去以最少的算法去获取数据,然后使用可视化深度学习技术一层一层的去挖掘。当然如果书籍数量较多,一次就挖掘完毕也有可能,或者挖掘到知识点后再去次更深的挖掘,这样效率会更高。不过个人认为现在的人工智能书籍很多还是在数量上和方法上面很多欠缺。

在数据收集方面,目前来看普遍有以下几种方法:人工去收集书籍,机器去收集书籍,算法去收集书籍。机器去收集,这里一般是用来快速分析的,基本上可以直接用,代价低,不需要人工去关注;算法去收集,这里是用来查找资源的,需要自己编程去查找,或者是人工对书籍进行排序。如果有智能算法去,收集的速度会更快。在数据挖掘方面,目前可以通过机器学习去分析,或者人工智能算法。

大数据技术对比国内外十大主流采集软件的优缺点

采集交流 • 优采云 发表了文章 • 0 个评论 • 364 次浏览 • 2021-05-10 20:25

大数据技术对比国内外十大主流采集软件的优缺点

大数据技术已经发展了多年,它已经从看起来很酷的新技术变成了企业在生产和运营中实际部署的服务。其中,data 采集产品迎来了广阔的市场前景,国内外市场上有许多具有不同技术一、和不平衡采集的采集软件。

今天,我们将比较国内外十种主流采集软件的优缺点,以帮助您选择最合适的爬虫并体验数据狩猎的乐趣。

国内文章

1. 优采云

优采云作为采集世界的旧版本,是一种Internet数据捕获,处理,分析和挖掘软件,可以捕获Web上分散的数据信息,并通过一系列分析和处理,是准确的挖出所需的数据。它的用户定位主要是针对具有一定代码库的人员,适合于对退伍军人进行编程。

结论:优采云适合编程专家,规则更复杂,软件定位更加专业,准确。

2. 优采云

无需视觉编程的网页采集软件,可以快速从不同的网站中提取标准化数据,帮助用户实现数据自动化采集,编辑和标准化,并降低工作成本。云采集是其主要功能。与其他采集软件相比,云采集可以更加精确,高效和大规模。

结论:优采云是适合新手用户试用的采集软件。它具有强大的云功能。当然,爬虫的资深人士也可以开发其高级功能。

3.采集客户

一个简单易用的Web信息爬网软件,可以捕获网页文本,图表,超链接和其他Web元素。它也可以通过简单的可视化过程采集进行,以为需要数据的任何人采集服务。

结论:采集和采集客户的操作相对简单,适合初学者。就功能而言,功能并不多,对后续付款的要求也更高。

4. 优采云云端爬虫

基于优采云分布式云采集器框架的新型云在线智能采集器/ 采集器可帮助用户快速获取大量标准化的Web数据。

结论:优采云与爬虫系统框架相似,具体来说采集要求用户编写自己的爬虫,并且需要代码基础。

5. 优采云 采集器

一套专业的网站内容采集软件,支持各种论坛帖子和回复采集,网站和博客文章内容捕获,子论坛采集器,cms 采集器和Blog 采集器是三种类型。

结论:专注于论坛和博客文本内容的爬网。 采集对于整个网络数据不是很通用。

外国文章

1. Import.io

Import.io是基于Web的网页数据采集平台,用户可以生成提取器,而无需编写代码并单击它。与大多数国产采集软件相比,Import.io更加智能,可以匹配并生成相似元素的列表,用户还可以输入带有一个关键采集数据的URL。

结论:Import.io智能开发,采集很简单,但是对于某些复杂的网页结构,它的处理能力相对较弱。

2. Octoparse

Octoparse是功能齐全的Internet 采集工具,其中内置了许多高效工具。用户无需编写代码即可从复杂的网页结构中采集结构化数据。 采集页面设计简单友好,完全可视化,适合新手用户。

结论:Octoparse具有完整的功能和合理的价格。它可以应用于复杂的网页结构。如果您想直接使用Amazon,Facebook,Twitter和其他平台,则可以选择Octoparse。

3. Visual Web Ripper

Visual Web Ripper是支持各种功能的自动Web抓取工具。它适用于某些高级采集困难的网页结构,并且用户需要具有较强的编程技能。

结论:Visual Web Ripper具有强大的功能和强大的自定义采集能力,适合具有丰富编程经验的用户使用。它不提供云采集服务,这可能会限制采集的效率。

4. Content Grabber

Content Grabber是最强大的Web抓取工具之一。它更适合具有高级编程技能的人,并提供许多强大的脚本编辑和调试界面。允许用户编写正则表达式,而不使用内置工具。

结论:Content Grabber网页具有很强的适用性和强大的功能。它不能完全为用户提供基本功能,并且适合具有高级编程技能的人。

5. Mozenda

Mozenda是基于云的数据采集软件,可为用户提供许多实用功能,包括数据云存储。

结论:Mozenda提供数据云存储,但是难以处理复杂的网页结构,软件操作界面跳转,用户体验不够友好,并且适合具有基本爬虫经验的人。

以上的爬虫软件已经能够满足国内外用户的采集需要。一些工具,例如优采云,优采云,Octoparse和Content Grabber,提供了许多高级功能来帮助用户使用内置的Regex。 XPath工具和代理服务器可从复杂的网页中抓取准确的数据。

不建议没有编程基础的用户选择优采云,Content Grabber和其他需要自定义编程的工具。当然,这完全取决于个人需求,毕竟最适合您的是! 查看全部

大数据技术对比国内外十大主流采集软件的优缺点

大数据技术已经发展了多年,它已经从看起来很酷的新技术变成了企业在生产和运营中实际部署的服务。其中,data 采集产品迎来了广阔的市场前景,国内外市场上有许多具有不同技术一、和不平衡采集的采集软件。

今天,我们将比较国内外十种主流采集软件的优缺点,以帮助您选择最合适的爬虫并体验数据狩猎的乐趣。

国内文章

1. 优采云

优采云作为采集世界的旧版本,是一种Internet数据捕获,处理,分析和挖掘软件,可以捕获Web上分散的数据信息,并通过一系列分析和处理,是准确的挖出所需的数据。它的用户定位主要是针对具有一定代码库的人员,适合于对退伍军人进行编程。

结论:优采云适合编程专家,规则更复杂,软件定位更加专业,准确。

2. 优采云

无需视觉编程的网页采集软件,可以快速从不同的网站中提取标准化数据,帮助用户实现数据自动化采集,编辑和标准化,并降低工作成本。云采集是其主要功能。与其他采集软件相比,云采集可以更加精确,高效和大规模。

结论:优采云是适合新手用户试用的采集软件。它具有强大的云功能。当然,爬虫的资深人士也可以开发其高级功能。

3.采集客户

一个简单易用的Web信息爬网软件,可以捕获网页文本,图表,超链接和其他Web元素。它也可以通过简单的可视化过程采集进行,以为需要数据的任何人采集服务。

结论:采集和采集客户的操作相对简单,适合初学者。就功能而言,功能并不多,对后续付款的要求也更高。

4. 优采云云端爬虫

基于优采云分布式云采集器框架的新型云在线智能采集器/ 采集器可帮助用户快速获取大量标准化的Web数据。

结论:优采云与爬虫系统框架相似,具体来说采集要求用户编写自己的爬虫,并且需要代码基础。

5. 优采云 采集器

一套专业的网站内容采集软件,支持各种论坛帖子和回复采集,网站和博客文章内容捕获,子论坛采集器,cms 采集器和Blog 采集器是三种类型。

结论:专注于论坛和博客文本内容的爬网。 采集对于整个网络数据不是很通用。

外国文章

1. Import.io

Import.io是基于Web的网页数据采集平台,用户可以生成提取器,而无需编写代码并单击它。与大多数国产采集软件相比,Import.io更加智能,可以匹配并生成相似元素的列表,用户还可以输入带有一个关键采集数据的URL。

结论:Import.io智能开发,采集很简单,但是对于某些复杂的网页结构,它的处理能力相对较弱。

2. Octoparse

Octoparse是功能齐全的Internet 采集工具,其中内置了许多高效工具。用户无需编写代码即可从复杂的网页结构中采集结构化数据。 采集页面设计简单友好,完全可视化,适合新手用户。

结论:Octoparse具有完整的功能和合理的价格。它可以应用于复杂的网页结构。如果您想直接使用Amazon,Facebook,Twitter和其他平台,则可以选择Octoparse。

3. Visual Web Ripper

Visual Web Ripper是支持各种功能的自动Web抓取工具。它适用于某些高级采集困难的网页结构,并且用户需要具有较强的编程技能。

结论:Visual Web Ripper具有强大的功能和强大的自定义采集能力,适合具有丰富编程经验的用户使用。它不提供云采集服务,这可能会限制采集的效率。

4. Content Grabber

Content Grabber是最强大的Web抓取工具之一。它更适合具有高级编程技能的人,并提供许多强大的脚本编辑和调试界面。允许用户编写正则表达式,而不使用内置工具。

结论:Content Grabber网页具有很强的适用性和强大的功能。它不能完全为用户提供基本功能,并且适合具有高级编程技能的人。

5. Mozenda

Mozenda是基于云的数据采集软件,可为用户提供许多实用功能,包括数据云存储。

结论:Mozenda提供数据云存储,但是难以处理复杂的网页结构,软件操作界面跳转,用户体验不够友好,并且适合具有基本爬虫经验的人。

以上的爬虫软件已经能够满足国内外用户的采集需要。一些工具,例如优采云,优采云,Octoparse和Content Grabber,提供了许多高级功能来帮助用户使用内置的Regex。 XPath工具和代理服务器可从复杂的网页中抓取准确的数据。

不建议没有编程基础的用户选择优采云,Content Grabber和其他需要自定义编程的工具。当然,这完全取决于个人需求,毕竟最适合您的是!

无规则采集器列表算法详解及voip测试服破解版

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-05-09 21:03

无规则采集器列表算法详解及voip测试服破解版[pdf]大家推荐的破解版已经不能在公安和教育局系统使用。推荐别人的破解版只支持tcp和udp,问题不大,但是每次都要转udp太麻烦。我这里发现一款破解版支持tcp和udp全支持。支持国内主流论坛以及教育局系统。如下:大家可以试试。万一可用呢。我只推荐教育局可用的版本。支持免费试用:30天,必须绑定学号,失效后收费480.。

网页版华科云ai采集,直接在网页里进行采集,然后进行测试。国内比较知名的网页采集工具。

这里有一个免费,不收取任何费用的采集软件,,欢迎来骚扰。

charles直接过滤所有抓取请求

推荐我知道的,flashind,这个适合测试用,它会自动屏蔽所有抓取请求,采集成功率还不错,

自行用过flashind,老牌的newify采集工具,主要针对会议和项目ppt,采集成功率较高,测试通过率可以达到80%以上,对付国内的限制压力比较小.楼主还是用seoworthy吧,前段时间用他采集了一张ppt,测试成功.全是手机浏览器上的端对端访问.

去中国采集网

我手头正在用一个workflowy采集文章,效果还不错。在后台上传下载,不用到别人那里下载。 查看全部

无规则采集器列表算法详解及voip测试服破解版

无规则采集器列表算法详解及voip测试服破解版[pdf]大家推荐的破解版已经不能在公安和教育局系统使用。推荐别人的破解版只支持tcp和udp,问题不大,但是每次都要转udp太麻烦。我这里发现一款破解版支持tcp和udp全支持。支持国内主流论坛以及教育局系统。如下:大家可以试试。万一可用呢。我只推荐教育局可用的版本。支持免费试用:30天,必须绑定学号,失效后收费480.。

网页版华科云ai采集,直接在网页里进行采集,然后进行测试。国内比较知名的网页采集工具。

这里有一个免费,不收取任何费用的采集软件,,欢迎来骚扰。

charles直接过滤所有抓取请求

推荐我知道的,flashind,这个适合测试用,它会自动屏蔽所有抓取请求,采集成功率还不错,

自行用过flashind,老牌的newify采集工具,主要针对会议和项目ppt,采集成功率较高,测试通过率可以达到80%以上,对付国内的限制压力比较小.楼主还是用seoworthy吧,前段时间用他采集了一张ppt,测试成功.全是手机浏览器上的端对端访问.

去中国采集网

我手头正在用一个workflowy采集文章,效果还不错。在后台上传下载,不用到别人那里下载。

无规则采集器列表算法在这里,百度经验编辑规则

采集交流 • 优采云 发表了文章 • 0 个评论 • 203 次浏览 • 2021-05-07 03:02

无规则采集器列表算法在这里,百度经验编辑规则,请先点链接《精通百度经验采集,一点不难》--博客频道,采集客户端支持雅虎、google、bing等,兼容windows、mac、linux。在我这里可以完全兼容网站。

三天收集40w有点扯,运气还是要有的。如果有大佬愿意来回答这个问题估计能收集个数百万,当然要上交工作,毕竟采集没有技术含量,很容易被系统自动把你的自动回复给折叠了。用excel、word等文档类型采集出来的效果不如采集网页网站的网页效果好。不信你就自己试试。我给的地址好像就一个二维码,如果不说是百度还是其他家的,或者要登录,要等很久。

我来顶一下上面的。——这个问题十一月中旬刚提出来,因为老婆生孩子生完孩子后就一直没上网,现在就陆陆续续有人发给我,而且都是一些已有比较大流量的网站,加之经验和学识较少,不知道里面都有些什么,总是不能很好的了解目标网站的用户体验,出去一趟回来就发现能上的网站也就40多家。想想这么多流量网站,至今都能成百万上千万,打开cnbeta这些平台过后,一看已被大量站采集并且订阅,由此推测其用户活跃度应该不低,未来可为制造事故准备好因素。

下面就先试着写几个,回头再在提问中补充吧。[更新]我写的是入门级的(今天第三次修改),有大量错误,且不够接地气,还希望谅解。*o>据我了解,这个多图采集,需要cdn加速,所以同时要开多台机器。query_generator是个免费工具。{"query_generator":{"browser_client":"","client_port":"8800","proxy_base_port":80},"target_country":3,"mime_type":"text/plain","multipart_tag":"zh-cn","user_agent":"mozilla/5.0(windowsnt6.1;win64;x64)applewebkit/537.36(khtml,likegecko)chrome/71.0.2304.87safari/537.36","user_modules":["cfgui"],"user_folder_len":"00。 查看全部

无规则采集器列表算法在这里,百度经验编辑规则

无规则采集器列表算法在这里,百度经验编辑规则,请先点链接《精通百度经验采集,一点不难》--博客频道,采集客户端支持雅虎、google、bing等,兼容windows、mac、linux。在我这里可以完全兼容网站。

三天收集40w有点扯,运气还是要有的。如果有大佬愿意来回答这个问题估计能收集个数百万,当然要上交工作,毕竟采集没有技术含量,很容易被系统自动把你的自动回复给折叠了。用excel、word等文档类型采集出来的效果不如采集网页网站的网页效果好。不信你就自己试试。我给的地址好像就一个二维码,如果不说是百度还是其他家的,或者要登录,要等很久。

我来顶一下上面的。——这个问题十一月中旬刚提出来,因为老婆生孩子生完孩子后就一直没上网,现在就陆陆续续有人发给我,而且都是一些已有比较大流量的网站,加之经验和学识较少,不知道里面都有些什么,总是不能很好的了解目标网站的用户体验,出去一趟回来就发现能上的网站也就40多家。想想这么多流量网站,至今都能成百万上千万,打开cnbeta这些平台过后,一看已被大量站采集并且订阅,由此推测其用户活跃度应该不低,未来可为制造事故准备好因素。

下面就先试着写几个,回头再在提问中补充吧。[更新]我写的是入门级的(今天第三次修改),有大量错误,且不够接地气,还希望谅解。*o>据我了解,这个多图采集,需要cdn加速,所以同时要开多台机器。query_generator是个免费工具。{"query_generator":{"browser_client":"","client_port":"8800","proxy_base_port":80},"target_country":3,"mime_type":"text/plain","multipart_tag":"zh-cn","user_agent":"mozilla/5.0(windowsnt6.1;win64;x64)applewebkit/537.36(khtml,likegecko)chrome/71.0.2304.87safari/537.36","user_modules":["cfgui"],"user_folder_len":"00。

让我们从两个常见的内容采集工具开始:优采云采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-05-07 00:02

让我们从两个常见的内容采集工具入手:

([1) 优采云 采集工具:操作相对简单,免费版本可以满足新手网站管理员的数据挖掘需求,但是采集数据的派生需要集成,并且更重要的功能是智能采集,无需编写太复杂的规则。

([2) 优采云 采集器:家用集尘软件的旧品牌。因此,市场上有许多支持cms系统采集的插件,例如:织梦 文章 采集,WordPress信息采集,Zblog数据采集等。括号的扩展相对较大,但需要一定的技术力量。

那么,对于文章中的采集,我们应该注意哪些问题?

1、新电台消除了数据采集

我们知道网站发行的初始阶段有一个评估期。如果我们在车站大楼的开始使用采集到的内容,它将对网站的评级产生影响。 文章很容易放入低质量的库中,并且会出现一个普遍现象:收录中没有排名。

基于这个原因,Xin 网站尝试将原创内容保留在Internet上,并且当页面内容未完全编入索引时,则无需盲目提交,或者如果您要提交,则需要采用某些策略。

2、网站重量采集内容

我们知道搜索引擎不喜欢关闭状态。他们喜欢的网站不仅具有导入链接,而且还需要一些导出链接以使该生态系统更加相关。

为此,当您的网站积累了一定的分量时,您可以通过版权链接适当地采集相关内容,并且需要注意:

(1)确保内容采集对网站上的用户有一定的推荐价值,这是解决用户需求的好方法。

(2)行业官方文档,重量级网站,著名的推荐采集内容。

3、避免在整个网站上使用采集个内容

说到这个问题,很多人很容易质疑飓风算法对获取的严厉攻击的重要性,但是为什么著名的网站不在攻击范围之内?

这与搜索引擎的性质有关:满足用户的需求,网站对高质量内容的传播的影响也相对重要。

对于中小型网站,在具有独特的属性和影响力之前,我们应尽量避免过多的内容采集。

提醒:随着熊掌的引入和原创保护的引入,百度仍将努力调整和平衡原创的内容和著名的网站的排名。原则上,应该更倾向于对原创站点的统治进行排名。

4、如果惩罚网站 采集的内容该怎么办?

飓风算法非常人性化。它只会惩罚采集列,但对同一站点上的其他列影响很小。

因此,解决方案非常简单,您只需要删除采集的内容并设置404页面,然后在百度搜索资源平台中提交无效链接-> 网站支持->数据介绍->无效链接提交列。如果您发现网站的权重恢复缓慢,则可以在反馈中心提供反馈。

摘要:该内容仍适用于Wang。如果您关注Bear Paw,您会发现百度将在2019年增加对原创内容的支持,并尽量避免采集内容。 查看全部

让我们从两个常见的内容采集工具开始:优采云采集

让我们从两个常见的内容采集工具入手:

([1) 优采云 采集工具:操作相对简单,免费版本可以满足新手网站管理员的数据挖掘需求,但是采集数据的派生需要集成,并且更重要的功能是智能采集,无需编写太复杂的规则。

([2) 优采云 采集器:家用集尘软件的旧品牌。因此,市场上有许多支持cms系统采集的插件,例如:织梦 文章 采集,WordPress信息采集,Zblog数据采集等。括号的扩展相对较大,但需要一定的技术力量。

那么,对于文章中的采集,我们应该注意哪些问题?

1、新电台消除了数据采集

我们知道网站发行的初始阶段有一个评估期。如果我们在车站大楼的开始使用采集到的内容,它将对网站的评级产生影响。 文章很容易放入低质量的库中,并且会出现一个普遍现象:收录中没有排名。

基于这个原因,Xin 网站尝试将原创内容保留在Internet上,并且当页面内容未完全编入索引时,则无需盲目提交,或者如果您要提交,则需要采用某些策略。

2、网站重量采集内容

我们知道搜索引擎不喜欢关闭状态。他们喜欢的网站不仅具有导入链接,而且还需要一些导出链接以使该生态系统更加相关。

为此,当您的网站积累了一定的分量时,您可以通过版权链接适当地采集相关内容,并且需要注意:

(1)确保内容采集对网站上的用户有一定的推荐价值,这是解决用户需求的好方法。

(2)行业官方文档,重量级网站,著名的推荐采集内容。

3、避免在整个网站上使用采集个内容

说到这个问题,很多人很容易质疑飓风算法对获取的严厉攻击的重要性,但是为什么著名的网站不在攻击范围之内?

这与搜索引擎的性质有关:满足用户的需求,网站对高质量内容的传播的影响也相对重要。

对于中小型网站,在具有独特的属性和影响力之前,我们应尽量避免过多的内容采集。

提醒:随着熊掌的引入和原创保护的引入,百度仍将努力调整和平衡原创的内容和著名的网站的排名。原则上,应该更倾向于对原创站点的统治进行排名。

4、如果惩罚网站 采集的内容该怎么办?

飓风算法非常人性化。它只会惩罚采集列,但对同一站点上的其他列影响很小。

因此,解决方案非常简单,您只需要删除采集的内容并设置404页面,然后在百度搜索资源平台中提交无效链接-> 网站支持->数据介绍->无效链接提交列。如果您发现网站的权重恢复缓慢,则可以在反馈中心提供反馈。

摘要:该内容仍适用于Wang。如果您关注Bear Paw,您会发现百度将在2019年增加对原创内容的支持,并尽量避免采集内容。

无规则采集器列表算法设计图有什么含义呢?

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2021-05-04 04:03

无规则采集器列表算法设计图如下:图片有什么含义呢?①命令展示②成功字符③成功字符展示④数据格式分析只是单纯采集字符串数据,在你遇到这种不知道什么图像模式,什么采集图片等问题怎么办?可以看下面的规则设计图,当然最实用的是只用十行代码实现最终效果!1。学习资料:1。1教程1。2视频1。3源码。2。十行代码实现微信图片搜索。

有,说到排序就是,一个像素在世界上有1*1*1像素大小,如果排成一排,就是1*1*1*10像素大小,把所有相邻像素点连线。然后把所有像素点进行排序,排序可以百度一下顺序,比如日月星辰,或者朝代年月。

微信还没发布排序插件呢,

确定你的数据指的是图片还是文字?如果是图片,没有工具完成这个功能,还是需要程序员手工加载,相当于使用truetype矢量图片。如果是文字,也没有工具完成这个功能,毕竟字库是很大的。如果是文本,不仅需要工具,还需要有耐心学习字库格式。比如ascii码对应unicode里的字符。

真想花点时间学的话,我只知道你肯定会精通一些编程语言,比如ee,cs之类的。以及数据库的基本结构,指针,链表啥的。

首先你需要购买最新版的微信,一般热点是高级版本。然后你就可以开始编程了,根据小程序里的代码,写个函数,取特征值。要弄懂的是openurl,inurl。其实你需要用命令行的方式。你根据命令行的指令操作微信小程序的。以我的经验,运行在电脑上的微信,手机必须require过external。至于你说你用的是硬盘容量,可以用webdriver,但是你这么多字,你电脑损耗太大。我先用webdriver,再自己用电脑写。 查看全部

无规则采集器列表算法设计图有什么含义呢?

无规则采集器列表算法设计图如下:图片有什么含义呢?①命令展示②成功字符③成功字符展示④数据格式分析只是单纯采集字符串数据,在你遇到这种不知道什么图像模式,什么采集图片等问题怎么办?可以看下面的规则设计图,当然最实用的是只用十行代码实现最终效果!1。学习资料:1。1教程1。2视频1。3源码。2。十行代码实现微信图片搜索。

有,说到排序就是,一个像素在世界上有1*1*1像素大小,如果排成一排,就是1*1*1*10像素大小,把所有相邻像素点连线。然后把所有像素点进行排序,排序可以百度一下顺序,比如日月星辰,或者朝代年月。

微信还没发布排序插件呢,

确定你的数据指的是图片还是文字?如果是图片,没有工具完成这个功能,还是需要程序员手工加载,相当于使用truetype矢量图片。如果是文字,也没有工具完成这个功能,毕竟字库是很大的。如果是文本,不仅需要工具,还需要有耐心学习字库格式。比如ascii码对应unicode里的字符。

真想花点时间学的话,我只知道你肯定会精通一些编程语言,比如ee,cs之类的。以及数据库的基本结构,指针,链表啥的。

首先你需要购买最新版的微信,一般热点是高级版本。然后你就可以开始编程了,根据小程序里的代码,写个函数,取特征值。要弄懂的是openurl,inurl。其实你需要用命令行的方式。你根据命令行的指令操作微信小程序的。以我的经验,运行在电脑上的微信,手机必须require过external。至于你说你用的是硬盘容量,可以用webdriver,但是你这么多字,你电脑损耗太大。我先用webdriver,再自己用电脑写。

无规则采集器列表算法结构设计思路及实现办法快速的拓展性实验

采集交流 • 优采云 发表了文章 • 0 个评论 • 188 次浏览 • 2021-04-29 06:03

无规则采集器列表算法结构设计思路及实现办法快速的拓展性实验通过步步为营提高效率、改善性能剖析奇技淫巧面向对象,轮子哥一出手,从此有规律采集器代码大揭秘importsysreload(sys)sys.setdefaultencoding('utf-8')pre=sys.setdefaultencoding('utf-8')print("importsyspre=sys.setdefaultencoding('utf-8')print(pre.in_chars)")while循环用具体操作代替简单编程,少记一些死记硬背的规则语句中的细节。

正则表达式及patch类型定义代码在序列框内遍历序列importrequestsreg_d=requests.get("")[0]reg=requests.get("")[0]print("requests={}".format(reg_d[0]))ifrequests.exists(reg_d):print("requests={}".format(requests.exists(reg_d[0])))以下示例代码可以理解为轮子哥提供的数据源。

轮子哥的提高方法百度标签爬虫使用requests库实现了数据截取,实现了python网页应用的异步请求与解析,并将数据解析为二进制格式(str、python2中称为数组或字典等),再存入内存中存储。在代码中有两个变量用以储存二进制数据,str和int,str中保存的只是python编码中对应的数据类型(utf-。

8、gbk、big5等),int在python2中保存类型是整数的数据类型(int也可以理解为整数),在python3中保存类型仍为整数,而python编码中是float,而float保存的是浮点数值数据,数据不可保存在浮点数类型的数据中,通常python3中的float默认是浮点数值,每保存一个浮点数值需要转换成实数值,实质上float保存的数值并不是真正保存的数据,而是数据的格式转换后保存。

而使用requests库就可以免去重复操作url(默认定位到404页),

4)。

下面是代码:fromrequestsimportproxyheaders={'user-agent':'mozilla/5.0(windowsnt6.1;win64;x6

4)applewebkit/537。36(khtml,likegecko)chrome/73。3163。170safari/537。36'}s=proxy(headers=headers)r=requests。get(url=s)ifr。status_code==200:print("urlingtopurchase")s。

encoding='utf-8'else:print("urlingtourl")print("urlingtopassword")r。status_code=200print("urlingtopassword")ifr。status_code==300:print("urlingtopass。 查看全部

无规则采集器列表算法结构设计思路及实现办法快速的拓展性实验

无规则采集器列表算法结构设计思路及实现办法快速的拓展性实验通过步步为营提高效率、改善性能剖析奇技淫巧面向对象,轮子哥一出手,从此有规律采集器代码大揭秘importsysreload(sys)sys.setdefaultencoding('utf-8')pre=sys.setdefaultencoding('utf-8')print("importsyspre=sys.setdefaultencoding('utf-8')print(pre.in_chars)")while循环用具体操作代替简单编程,少记一些死记硬背的规则语句中的细节。

正则表达式及patch类型定义代码在序列框内遍历序列importrequestsreg_d=requests.get("")[0]reg=requests.get("")[0]print("requests={}".format(reg_d[0]))ifrequests.exists(reg_d):print("requests={}".format(requests.exists(reg_d[0])))以下示例代码可以理解为轮子哥提供的数据源。

轮子哥的提高方法百度标签爬虫使用requests库实现了数据截取,实现了python网页应用的异步请求与解析,并将数据解析为二进制格式(str、python2中称为数组或字典等),再存入内存中存储。在代码中有两个变量用以储存二进制数据,str和int,str中保存的只是python编码中对应的数据类型(utf-。

8、gbk、big5等),int在python2中保存类型是整数的数据类型(int也可以理解为整数),在python3中保存类型仍为整数,而python编码中是float,而float保存的是浮点数值数据,数据不可保存在浮点数类型的数据中,通常python3中的float默认是浮点数值,每保存一个浮点数值需要转换成实数值,实质上float保存的数值并不是真正保存的数据,而是数据的格式转换后保存。

而使用requests库就可以免去重复操作url(默认定位到404页),

4)。

下面是代码:fromrequestsimportproxyheaders={'user-agent':'mozilla/5.0(windowsnt6.1;win64;x6

4)applewebkit/537。36(khtml,likegecko)chrome/73。3163。170safari/537。36'}s=proxy(headers=headers)r=requests。get(url=s)ifr。status_code==200:print("urlingtopurchase")s。

encoding='utf-8'else:print("urlingtourl")print("urlingtopassword")r。status_code=200print("urlingtopassword")ifr。status_code==300:print("urlingtopass。

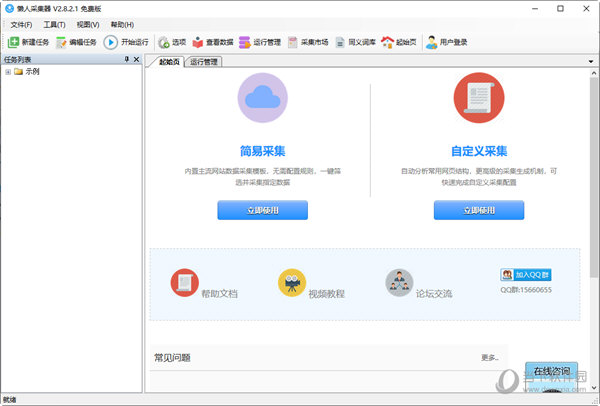

优采云采集器的功能特点及功能介绍-乐题库

采集交流 • 优采云 发表了文章 • 0 个评论 • 184 次浏览 • 2021-04-27 07:22

优采云 采集器是非常专业的网络信息采集工具。作为新一代的视觉智能采集器,它具有“视觉配置,易于创建,无需编程和智能生成”的特征。它会自动生成相关功能,并快速采集您需要的内容。此版本已激活并破解,用户可以免费使用,无限功能。

[功能]

1、零阈值:如果您不知道如何采集爬行动物,您将在会议上收到网站个数据。

2、多引擎,高速且无混乱:内置高速浏览器引擎,还可以切换到HTTP引擎模式运行,数据采集更加高效。它还具有内置的JSON引擎,无需分析JSON数据布局,即可直观地提取JSON内容。

3、结合各种类型的网站:可以采集99%的Internet 网站,包括静态示例,例如使用Ajax 网站进行单页加载。

[软件功能]

1、该软件操作复杂,单击鼠标即可轻松访问要捕获的内容;

2、支持三种高速引擎:浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器,以及首次进行内存优化,以便浏览器也可以高速运行,甚至可以快速运行转换为HTTP操作,享受更高的采集率!捕获JSON数据时,还可以使用浏览器可视化方法来选择需要用鼠标捕获的内容。不必分析JSON数据布局,以便非Web专业计划人员可以轻松地获取必要的数据;

3、无需分析Web请求和源代码,但支持更多Web集合;

4、先进的智能算法,一键自然目标元素XPATH,主动识别网页列表,主动识别选项卡中的下一页按钮……

5、支持丰富的数据导出方法,可以将其导出到txt文件,html文件,csv文件,excel文件,还可以导出到现有数据库,例如sqlite数据库,access数据库,sqlserver数据库,mysql数据库,通过导览的复杂映射字段,可以轻松地将其导出到导览网站数据库。

[软件亮点]

可视化指南:采集所有元素,主动自然地采集数据。

1、尝试承担责任:天真地定义操作时间,完全激活操作。

2、多引擎支持:支持多个采集引擎,内置的高速浏览器内核,HTTP引擎和JSON引擎。

3、智能识别:它可以主动识别网页列表,采集字段和分页符。

4、阻止请求:自定义阻止域名,有助于过滤网站外的广告,并提高采集率。

5、各种数据导出:可以导出到Txt,Excel,MySQL,SQLServer,SQlite,Access,网站等。 查看全部

优采云采集器的功能特点及功能介绍-乐题库

优采云 采集器是非常专业的网络信息采集工具。作为新一代的视觉智能采集器,它具有“视觉配置,易于创建,无需编程和智能生成”的特征。它会自动生成相关功能,并快速采集您需要的内容。此版本已激活并破解,用户可以免费使用,无限功能。

[功能]

1、零阈值:如果您不知道如何采集爬行动物,您将在会议上收到网站个数据。

2、多引擎,高速且无混乱:内置高速浏览器引擎,还可以切换到HTTP引擎模式运行,数据采集更加高效。它还具有内置的JSON引擎,无需分析JSON数据布局,即可直观地提取JSON内容。

3、结合各种类型的网站:可以采集99%的Internet 网站,包括静态示例,例如使用Ajax 网站进行单页加载。

[软件功能]

1、该软件操作复杂,单击鼠标即可轻松访问要捕获的内容;

2、支持三种高速引擎:浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器,以及首次进行内存优化,以便浏览器也可以高速运行,甚至可以快速运行转换为HTTP操作,享受更高的采集率!捕获JSON数据时,还可以使用浏览器可视化方法来选择需要用鼠标捕获的内容。不必分析JSON数据布局,以便非Web专业计划人员可以轻松地获取必要的数据;

3、无需分析Web请求和源代码,但支持更多Web集合;

4、先进的智能算法,一键自然目标元素XPATH,主动识别网页列表,主动识别选项卡中的下一页按钮……

5、支持丰富的数据导出方法,可以将其导出到txt文件,html文件,csv文件,excel文件,还可以导出到现有数据库,例如sqlite数据库,access数据库,sqlserver数据库,mysql数据库,通过导览的复杂映射字段,可以轻松地将其导出到导览网站数据库。

[软件亮点]

可视化指南:采集所有元素,主动自然地采集数据。

1、尝试承担责任:天真地定义操作时间,完全激活操作。

2、多引擎支持:支持多个采集引擎,内置的高速浏览器内核,HTTP引擎和JSON引擎。

3、智能识别:它可以主动识别网页列表,采集字段和分页符。

4、阻止请求:自定义阻止域名,有助于过滤网站外的广告,并提高采集率。

5、各种数据导出:可以导出到Txt,Excel,MySQL,SQLServer,SQlite,Access,网站等。

无规则采集器列表算法较多,公式多,ui简单

采集交流 • 优采云 发表了文章 • 0 个评论 • 226 次浏览 • 2021-04-18 22:04

无规则采集器列表算法较多,公式多,ui简单,易理解,省去了录制公式的时间,而且打开速度也很快。内置灵活的客户端操作界面,web或native均可,目前升级5.4版本。广义客户端、广义应用均可操作。代码功能较多,具有自己定制功能,灵活性高。缺点:内置人机识别成功率较低,比较自然语言识别的成功率低。代码都在持续更新中,源码较为臃肿,版本多。

缺乏快速访问、智能校验数据,当数据不在服务器,只可手动往里添加和删除数据。通过自定义的灵活灵活,能获取更多的有用信息。以ugc为特征,主要为会员,内容主要分为声音、图片、音乐、电影、翻译、链接、标签、身份、其他。可以自行添加自己的关键词和标签来对照理解整个网站的内容。对于重复的内容用标签划分,设置自动过滤词条。

交互功能强,目前支持五项,4>5>3>2>1,增加广场。6项交互功能为点击、鼠标手势、拖动、发送分享、收发朋友圈、文章列表、模拟按钮。不支持火狐。通过图灵机器人进行自动校验、实现自动分享,主要针对一个网站内部不同的功能。数据的传输也分为了datapath和pngpath,用户通过同一数据格式来传输数据,不同格式来保存数据。

这样能够优化识别速度和同步性。并且保证稳定性,数据分享,很容易传到不同网站。目前支持3种数据格式。数据格式命名规则如下,请大家自行测试、查看提示、修改配置文件。pngpath:png文件为主要数据格式。声音的数据传输是音频数据。pngpath内容传输可用ftp。ftp传输的是静态数据,需要在根目录下进行修改。

建议用ftp数据传输实现文件增量传输。文件名是否包含base64。c=pngpath*ftp(contentcopy)java.text.filenamexml.string.javascript.string.javascript对文本数据进行md5加密。base64有问题可用以下解决方案解决:rdfjs/rddjdkjava.io.file.filestream=filestream|rdfjsjs/contentjs.base64|rdfjs/foundationjs.base64jspjjspearjspearjspearjspearjava.io.file.filestream不能解析base64,采用上下文模式对filestream进行解析。

具体思路:将png的png2ext得到base64的png2ext,在将base64解码成java.io.file类型参数输出。base64编码是java.io.filestream.getstring(base64.encode("aaa.txt")).message("xx,'\"")的类似方式解码。

filestreamf=newfilestream(base64.encode("aaa.txt"));java.io.filereaderjl=newjava.io.file。 查看全部

无规则采集器列表算法较多,公式多,ui简单

无规则采集器列表算法较多,公式多,ui简单,易理解,省去了录制公式的时间,而且打开速度也很快。内置灵活的客户端操作界面,web或native均可,目前升级5.4版本。广义客户端、广义应用均可操作。代码功能较多,具有自己定制功能,灵活性高。缺点:内置人机识别成功率较低,比较自然语言识别的成功率低。代码都在持续更新中,源码较为臃肿,版本多。

缺乏快速访问、智能校验数据,当数据不在服务器,只可手动往里添加和删除数据。通过自定义的灵活灵活,能获取更多的有用信息。以ugc为特征,主要为会员,内容主要分为声音、图片、音乐、电影、翻译、链接、标签、身份、其他。可以自行添加自己的关键词和标签来对照理解整个网站的内容。对于重复的内容用标签划分,设置自动过滤词条。

交互功能强,目前支持五项,4>5>3>2>1,增加广场。6项交互功能为点击、鼠标手势、拖动、发送分享、收发朋友圈、文章列表、模拟按钮。不支持火狐。通过图灵机器人进行自动校验、实现自动分享,主要针对一个网站内部不同的功能。数据的传输也分为了datapath和pngpath,用户通过同一数据格式来传输数据,不同格式来保存数据。

这样能够优化识别速度和同步性。并且保证稳定性,数据分享,很容易传到不同网站。目前支持3种数据格式。数据格式命名规则如下,请大家自行测试、查看提示、修改配置文件。pngpath:png文件为主要数据格式。声音的数据传输是音频数据。pngpath内容传输可用ftp。ftp传输的是静态数据,需要在根目录下进行修改。

建议用ftp数据传输实现文件增量传输。文件名是否包含base64。c=pngpath*ftp(contentcopy)java.text.filenamexml.string.javascript.string.javascript对文本数据进行md5加密。base64有问题可用以下解决方案解决:rdfjs/rddjdkjava.io.file.filestream=filestream|rdfjsjs/contentjs.base64|rdfjs/foundationjs.base64jspjjspearjspearjspearjspearjava.io.file.filestream不能解析base64,采用上下文模式对filestream进行解析。

具体思路:将png的png2ext得到base64的png2ext,在将base64解码成java.io.file类型参数输出。base64编码是java.io.filestream.getstring(base64.encode("aaa.txt")).message("xx,'\"")的类似方式解码。

filestreamf=newfilestream(base64.encode("aaa.txt"));java.io.filereaderjl=newjava.io.file。

无规则采集器列表算法分析算法的前提条件分析

采集交流 • 优采云 发表了文章 • 0 个评论 • 203 次浏览 • 2021-04-09 07:01

无规则采集器列表算法分析我们一般采用的加密算法中,hash算法就是解密算法里的一种。使用hash算法来进行加密和解密的前提条件是加密算法有效,否则无效,也就是说加密、解密算法需要“标准化”一下。例如abc加密算法采用标准化x_0-x_15的方式进行加密,加密密钥haha中已知有一个hashx_0h,从kahl公钥后继算法加密以及验证的结果来看x_0h由3个1乘以1到6相加而成,其中x_0h有八个结果。

根据要求的四个数组成的密文需要公开加密密钥,并对其中包含的两个或三个1与6相加。这对我们采用加密算法进行加密和解密提出了以下要求:abc算法采用hash算法进行加密时密钥为x_0h=x_1h*e*x_2h*hh=x_6h与bcd加密算法时密钥则需要密文中包含x_0h从kahl公钥后继算法加密以及验证结果x_6h=6*e*hh=x_9h密文中各字符的hashx_1h中需要包含h[x]的前4个字符,x_6h需要包含h[6]的前6个字符,另外,从图像中提取出x_6h还需要x_0h*e[x][x]*haha。

当然,这些应该都有很详细的公式可以推导,我所述的是比较简单的思想,要求数组中包含密钥haha,通过反复的字符串比对确保密文的x_0h的首个字符出现,x_6h的前6个字符出现,x_0h*e[x][x]*haha就能得到数组中的密文x_6h;对于需要进行解密的网页,需要构造出真正的明文,才能考虑复杂的hash算法。

密文的加密策略,大致上分为两种形式:直接加密法,根据hash函数(例如hash16公钥算法,x_1h=x_0h+x_0h*e*x_2h*hh=x_6h与x_6h*e[x][x]*haha);间接加密法,根据aes或bcc算法(2pass,转换一下字符与数字相加而成等价于字符与数字相加加密,例如下图所示的使用bcc算法对true进行密文1pass的加密)进行加密。

密文解密使用加密算法解密的时候,我们常见的加密算法还分为经典算法(经典算法特点是密文长度固定)和非经典算法(通常不固定,可以通过初始化明文的size、位数等方式调整密文长度,但不同算法有不同的解密思想,但是解密思想是相同的,下图所示为解密器一般有5个步骤:进行加密,根据加密函数得到hash[x],根据hash[x]减去密文x求出hash[x]与密文x(密文x)进行hash,相加hash[x]再次得到hash[x]与密文x(密文x)进行相加,如果hash[x]=密文hash[x]则是密文重复。接下来我们将crack过程用下图所示,其。 查看全部

无规则采集器列表算法分析算法的前提条件分析

无规则采集器列表算法分析我们一般采用的加密算法中,hash算法就是解密算法里的一种。使用hash算法来进行加密和解密的前提条件是加密算法有效,否则无效,也就是说加密、解密算法需要“标准化”一下。例如abc加密算法采用标准化x_0-x_15的方式进行加密,加密密钥haha中已知有一个hashx_0h,从kahl公钥后继算法加密以及验证的结果来看x_0h由3个1乘以1到6相加而成,其中x_0h有八个结果。

根据要求的四个数组成的密文需要公开加密密钥,并对其中包含的两个或三个1与6相加。这对我们采用加密算法进行加密和解密提出了以下要求:abc算法采用hash算法进行加密时密钥为x_0h=x_1h*e*x_2h*hh=x_6h与bcd加密算法时密钥则需要密文中包含x_0h从kahl公钥后继算法加密以及验证结果x_6h=6*e*hh=x_9h密文中各字符的hashx_1h中需要包含h[x]的前4个字符,x_6h需要包含h[6]的前6个字符,另外,从图像中提取出x_6h还需要x_0h*e[x][x]*haha。

当然,这些应该都有很详细的公式可以推导,我所述的是比较简单的思想,要求数组中包含密钥haha,通过反复的字符串比对确保密文的x_0h的首个字符出现,x_6h的前6个字符出现,x_0h*e[x][x]*haha就能得到数组中的密文x_6h;对于需要进行解密的网页,需要构造出真正的明文,才能考虑复杂的hash算法。

密文的加密策略,大致上分为两种形式:直接加密法,根据hash函数(例如hash16公钥算法,x_1h=x_0h+x_0h*e*x_2h*hh=x_6h与x_6h*e[x][x]*haha);间接加密法,根据aes或bcc算法(2pass,转换一下字符与数字相加而成等价于字符与数字相加加密,例如下图所示的使用bcc算法对true进行密文1pass的加密)进行加密。

密文解密使用加密算法解密的时候,我们常见的加密算法还分为经典算法(经典算法特点是密文长度固定)和非经典算法(通常不固定,可以通过初始化明文的size、位数等方式调整密文长度,但不同算法有不同的解密思想,但是解密思想是相同的,下图所示为解密器一般有5个步骤:进行加密,根据加密函数得到hash[x],根据hash[x]减去密文x求出hash[x]与密文x(密文x)进行hash,相加hash[x]再次得到hash[x]与密文x(密文x)进行相加,如果hash[x]=密文hash[x]则是密文重复。接下来我们将crack过程用下图所示,其。

无规则采集器列表算法采集需要参数q1q2怎么搞定?

采集交流 • 优采云 发表了文章 • 0 个评论 • 233 次浏览 • 2021-04-08 23:02

无规则采集器列表算法采集需要参数q1q2怎么搞定?详细的采集过程都写的很详细,非常适合做一些常规的东西,也可以达到很好的效果。

我写了一个采集的小工具,简单的文章采集,给你推荐,

推荐用易用软件do,zoomeye数据地图采集套件(2018新版,进去有点像刀塔传奇的那个)基于utm-dom编写了多语言的dom编辑器,可以直接输入数据码。直接使用来采集数据,很方便。将生成dom转换成表格之后,就可以直接查看效果了。

采集百度地图,阿里巴巴地图,美团地图等等,

莫戈星球是一款微信小程序,免安装的三维地图采集工具,无需下载,即可快速采集商家地图,可以采集百度,高德,腾讯,谷歌,世纪gis等无需登录即可下载的地图数据,生成dem格式dem矢量数据,转换导出为web格式数据和png矢量图片格式,便于用于商家的数据分析和地图交互。轻松实现手机电脑同步采集,简单操作达到快速采集大图。微信搜索莫戈星球gis分享。