抓取网页数据

抓取网页数据 学完Python后,都能干点什么?

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2022-05-02 14:13

Python是一种全栈的开发语言,你如果能学好Python,前端,后端,测试,大数据分析,爬虫等这些工作你都能胜任。

当下Python有多火我不再赘述,Python有哪些作用呢?

相比其他静态编程语言,如java,c#,C++,python抓取网页文档的接口更简洁;相比其他动态脚本语言,如perl,shell,python的urllib2包提供了较为完整的访问网页文档的API。

此外,抓取网页有时候需要模拟浏览器的行为,很多网站对于生硬的爬虫抓取都是封杀的。在python里都有非常优秀的第三方包帮你搞定,如Requests,mechanize。

抓取的网页通常需要处理,比如过滤html标签,提取文本等。python的beautifulsoap提供了简洁的文档处理功能,能用极短的代码完成大部分文档的处理。

其实以上功能很多语言和工具都能做,但是用python能够干得最快,最干净。

就目前Python发展而言,Python主要有以下五大主要应用:

接下来和大家一一聊聊学完python之后可以从事哪些方面的工作:

Python Web开发工程师:我们都知道Web网站开发一直都是所有互联网公司开发的重点之一,我们离不开互联网,离不开Web技术,利用Python的Web框架可以迅速开发Web应用。

Python爬虫开发工程师:在当前信息大爆炸时代,大量的信息都通过Web来展示,为了获取这些数据,网络爬虫工程师就应运而生,除了日常的抓取数据和解析数据的需求,还能够突破普通网站常见的反爬虫机制,以及更深层次的爬虫采集算法的编写。

Python大数据工程师:在大数据时代,数据是公司的核心资产,从杂乱无章的数据中提取有价值的信息或者规律,成为了数据分析师的首要任务,而Python的工具链为这项繁重的工作提供了极高的效率支持。

Python人工智能工程师:人工智能的迅速发展将深刻改变人类社会生活、改变世界。为抢抓人工智能发展的重大战略机遇,构筑我国人工智能发展的先发优势,加快建设创新型国家和世界科技强国,当前人工智能发展进入新阶段。

Python拥有强大的脚本处理功能,它在操作Linux系统方面具有先天的优势,许多云平台、运维监控管理工具都是使用Python开发的,Python自动化运维让运维工程师的工作量减少效率提高!

当然也不是说让所有人都去追逐新技术,什么流行学什么。工作或者学习之余,学些热门技术,可以让自己保持敏锐度和竞争力,因为说不好什么时候这些热门技术就成了你的饭碗。 查看全部

抓取网页数据 学完Python后,都能干点什么?

Python是一种全栈的开发语言,你如果能学好Python,前端,后端,测试,大数据分析,爬虫等这些工作你都能胜任。

当下Python有多火我不再赘述,Python有哪些作用呢?

相比其他静态编程语言,如java,c#,C++,python抓取网页文档的接口更简洁;相比其他动态脚本语言,如perl,shell,python的urllib2包提供了较为完整的访问网页文档的API。

此外,抓取网页有时候需要模拟浏览器的行为,很多网站对于生硬的爬虫抓取都是封杀的。在python里都有非常优秀的第三方包帮你搞定,如Requests,mechanize。

抓取的网页通常需要处理,比如过滤html标签,提取文本等。python的beautifulsoap提供了简洁的文档处理功能,能用极短的代码完成大部分文档的处理。

其实以上功能很多语言和工具都能做,但是用python能够干得最快,最干净。

就目前Python发展而言,Python主要有以下五大主要应用:

接下来和大家一一聊聊学完python之后可以从事哪些方面的工作:

Python Web开发工程师:我们都知道Web网站开发一直都是所有互联网公司开发的重点之一,我们离不开互联网,离不开Web技术,利用Python的Web框架可以迅速开发Web应用。

Python爬虫开发工程师:在当前信息大爆炸时代,大量的信息都通过Web来展示,为了获取这些数据,网络爬虫工程师就应运而生,除了日常的抓取数据和解析数据的需求,还能够突破普通网站常见的反爬虫机制,以及更深层次的爬虫采集算法的编写。

Python大数据工程师:在大数据时代,数据是公司的核心资产,从杂乱无章的数据中提取有价值的信息或者规律,成为了数据分析师的首要任务,而Python的工具链为这项繁重的工作提供了极高的效率支持。

Python人工智能工程师:人工智能的迅速发展将深刻改变人类社会生活、改变世界。为抢抓人工智能发展的重大战略机遇,构筑我国人工智能发展的先发优势,加快建设创新型国家和世界科技强国,当前人工智能发展进入新阶段。

Python拥有强大的脚本处理功能,它在操作Linux系统方面具有先天的优势,许多云平台、运维监控管理工具都是使用Python开发的,Python自动化运维让运维工程师的工作量减少效率提高!

当然也不是说让所有人都去追逐新技术,什么流行学什么。工作或者学习之余,学些热门技术,可以让自己保持敏锐度和竞争力,因为说不好什么时候这些热门技术就成了你的饭碗。

爬虫抓取数据为什么要使用代理

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-05-01 15:08

大数据时代,我们需要海量的信息去帮助我们分析市场、分析用户,因此在爬虫抓取数据的时候,就容易出现IP受限问题。有的网站也会采取防爬取技术,当我们采集信息频次过快的时候,有可能就会被禁止访问网页。这时候我们就需要使用代理IP软件,来更换我们的IP地址。一般情况下,用户自己是没有能力搞定代理IP问题的,一则技术含量太高,二则成本也太高。这时,我们就需要选择专业的代理商。携趣代理软件建议大家,最好选择付费代理IP。因为免费的代理IP不一定可以使用,有可能你在使用的过程中,会突然发现IP地址不可用或者已经失效了。为了可以顺利的完成工作任务,一定要选择安全可靠的代理。携趣代理软件可以为您提供安全高效的IP服务,为您量身打造行业资讯推荐、软件使用技巧,更有专业人士为您定制IP服务,是您建站维护的首要选择。更多资讯,请点击或添加客服咨询。 查看全部

爬虫抓取数据为什么要使用代理

大数据时代,我们需要海量的信息去帮助我们分析市场、分析用户,因此在爬虫抓取数据的时候,就容易出现IP受限问题。有的网站也会采取防爬取技术,当我们采集信息频次过快的时候,有可能就会被禁止访问网页。这时候我们就需要使用代理IP软件,来更换我们的IP地址。一般情况下,用户自己是没有能力搞定代理IP问题的,一则技术含量太高,二则成本也太高。这时,我们就需要选择专业的代理商。携趣代理软件建议大家,最好选择付费代理IP。因为免费的代理IP不一定可以使用,有可能你在使用的过程中,会突然发现IP地址不可用或者已经失效了。为了可以顺利的完成工作任务,一定要选择安全可靠的代理。携趣代理软件可以为您提供安全高效的IP服务,为您量身打造行业资讯推荐、软件使用技巧,更有专业人士为您定制IP服务,是您建站维护的首要选择。更多资讯,请点击或添加客服咨询。

数据分析实战(7):手把手教你Python爬取新房数据

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2022-05-01 07:22

http://www.fz0752.com/project/ ... %3Bbr />

很显然,这是静态网页,翻页参数为「pageNO」,区域参数为「qy」,其余参数也很好理解,点击对应筛选项即可发现网页链接变化。

咱们可以通过遍历区域和页码,将新房列表的房源URL提取下来,再遍历这些URL,抓取到每个房源的详情信息。

详情页分析

选择一个新房URL,点击进去,链接如下:

http://newhouse.fz0752.com/fon ... %3Bbr />

即这个新房的id为「」,再点击详情信息,链接变为:

http://newhouse.fz0752.com/pro ... %3Bbr />

即这个新房的「详情信息」的id为「20170060」,我们可以大胆假设这个id就是新房id截取的一部分。多找几个新房点击尝试,很容易验证这个规律。

反爬分析

相同的ip地址频繁访问同一个网页会有被封风险,本文采用fake_useragent,将随机生成的User-Agent请求头去访问网页,将减少ip封锁的风险。

代码实现

导入爬虫相关库,定义一个主函数,构建区域列表(不同区域对应不用的区域id),遍历并用requests去请求由区域参数和页码参数拼接的URL。这里将页码设置50上限,当遍历的某个房源URL长度为0(即不存在新房数据)时,直接break,让程序进行下一个区域的遍历,直至所有数据抓取完毕,程序停止。

# -*- coding = uft-8 -*-<br /># @Time : 2020/12/21 9:29 下午<br /># @Author : J哥<br /># @File : newhouse.py<br /><br />import csv<br />import time<br />import random<br />import requests<br />import traceback<br />from lxml import etree<br />from fake_useragent import UserAgent<br /><br />def main():<br /> #46:惠城区,47:仲恺区,171:惠阳区,172:大亚湾,173:博罗县,174:惠东县,175:龙门县<br /> qy_list = [46,47,171,172,173,174,175]<br /> for qy in qy_list: #遍历区域<br /> for page in range(1,50): #遍历页数<br /> url = f'http://www.fz0752.com/project/list.shtml?state=&key=&qy={qy}&area=&danjia=&func=&fea=&type=&kp=&mj=&sort=&pageNO={page}'<br /> response = requests.request("GET", url, headers = headers,timeout = 5)<br /> print(response.status_code)<br /> if response.status_code == 200:<br /> re = response.content.decode('utf-8')<br /> print("正在提取" + str(qy) +'第' + str(page) + "页")<br /> #time.sleep(random.uniform(1, 2))<br /> print("-" * 80)<br /> # print(re)<br /> parse = etree.HTML(re)<br /> get_href(parse,qy)<br /> num = ''.join(parse.xpath('//*[@id="parent-content"]/div/div[6]/div/div[1]/div[2]/div[1]/div[2]/div[1]/div[1]/a/@href'))<br /> print(len(num))<br /> if len(num) == 0:<br /> break<br /><br />if __name__ == '__main__':<br /> ua = UserAgent(verify_ssl=False)<br /> headers = {"User-Agent": ua.random}<br /> time.sleep(random.uniform(1, 2))<br /> main()<br />

发送请求,获取新房列表网页,并解析到所有新房URL,同时将新房id替换为详情信息id。在程序运行中发现有少数新房URL不一致,因此这里做了判断,修改后可以获取完整的详情信息id,并拼接出对应的URL。

def get_href(parse,qy):<br /> items = parse.xpath('//*[@id="parent-content"]/div/div[6]/div/div[1]/div[2]/div')<br /> try:<br /> for item in items:<br /> href = ''.join(item.xpath('./div[2]/div[1]/div[1]/a/@href')).strip()<br /> print("初始href为:",href)<br /> #print(len(href))<br /> if len(href) > 25:<br /> href1 = 'http://newhouse.fz0752.com/project/detail.shtml?num=' + href[52:].replace(".html","")<br /> else:<br /> href1 = 'http://newhouse.fz0752.com/project/detail.shtml?num=' + href[15:]<br /> print("详情href为:",href1)<br /> try:<br /> get_detail(href1,qy)<br /> except:<br /> pass<br /> except Exception:<br /> print(traceback.print_exc())<br />

打印结果如下:

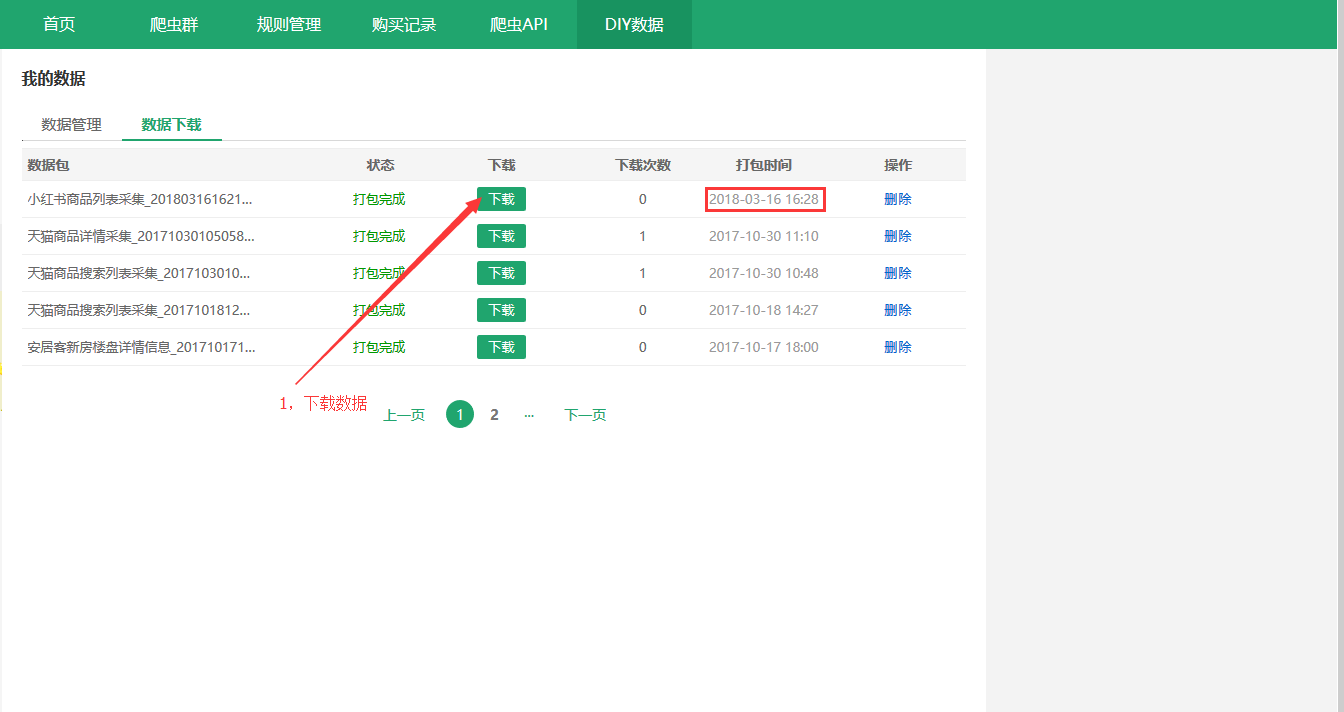

详情信息URL找到后,定义一个函数去请求详情页数据,同时携带qy参数,最后将其保存到csv中。

def get_detail(href1,qy):<br /> time.sleep(random.uniform(1, 2))<br /> response = requests.get(href1, headers=headers,timeout = 5)<br /> if response.status_code == 200:<br /> source = response.text<br /> html = etree.HTML(source)<br />

开始解析详情页中的各个字段,这里用到xpath进行数据解析,由于需要解析的字段太多,高达41个,限于篇幅,以下仅给出部分字段解析代码。当然,其他字段解析基本一样。

#项目状态<br />try:<br /> xmzt = html.xpath('//*[@id="parent-content"]/div/div[3]/div[3]/div[1]/div[1]/text()')[0].strip()<br />except:<br /> xmzt = None<br />#项目名称<br />try:<br /> name = html.xpath('//*[@id="parent-content"]/div/div[3]/div[3]/div[1]/h1/text()')[0].strip()<br />except:<br /> name = None<br />#项目简介<br />ps = html.xpath('//*[@id="parent-content"]/div/div[3]/div[5]/div[2]/div')<br />for p in ps:<br /> try:<br /> xmjj = p.xpath('./p[1]/text()')[0].strip()<br /> except:<br /> xmjj = None<br />infos = html.xpath('//*[@id="parent-content"]/div/div[3]/div[5]/div[1]/div/table/tbody')<br />for info in infos:<br /> #行政区域<br /> try:<br /> xzqy = info.xpath('./tr[1]/td[1]/text()')[0].strip()<br /> except:<br /> xzqy = None<br /> #物业类型<br /> try:<br /> wylx = info.xpath('./tr[2]/td[1]/text()')[0].strip()<br /> except:<br /> wylx = None<br /> #销售价格<br /> try:<br /> xsjg = info.xpath('./tr[3]/td[1]/text()')[0].strip()<br /> except:<br /> xsjg = None<br /> ······<br /> data = {<br /> 'xmzt':xmzt,<br /> 'name':name,<br /> 'xzqy':xzqy,<br /> ······<br /> 'qy':qy<br /> }<br /> print(data)<br />

解析完数据后,将其置于字典中,打印结果如下:

然后追加保存为csv:

try:<br /> with open('hz_newhouse.csv', 'a', encoding='utf_8_sig', newline='') as fp:<br /> fieldnames = ['xmzt','name','xzqy',······,'qy']<br /> writer = csv.DictWriter(fp, fieldnames = fieldnames)<br /> writer.writerow(data)<br />except Exception:<br /> print(traceback.print_exc())<br />

当然,我们也可以读取csv文件,并写入Excel:

df = pd.read_csv("newhouse.csv",names=['name','xzqy','wylx',······,'state'])<br />df = df.drop_duplicates()<br />df.to_excel("newhouse.xlsx",index=False)<br />

总结

本文基于Python爬虫技术,提供了一种更直观的抓取新房数据的方法。

不建议抓取太多,容易使得服务器负载,浅尝辄止即可。

查看全部

数据分析实战(7):手把手教你Python爬取新房数据

http://www.fz0752.com/project/ ... %3Bbr />

很显然,这是静态网页,翻页参数为「pageNO」,区域参数为「qy」,其余参数也很好理解,点击对应筛选项即可发现网页链接变化。

咱们可以通过遍历区域和页码,将新房列表的房源URL提取下来,再遍历这些URL,抓取到每个房源的详情信息。

详情页分析

选择一个新房URL,点击进去,链接如下:

http://newhouse.fz0752.com/fon ... %3Bbr />

即这个新房的id为「」,再点击详情信息,链接变为:

http://newhouse.fz0752.com/pro ... %3Bbr />

即这个新房的「详情信息」的id为「20170060」,我们可以大胆假设这个id就是新房id截取的一部分。多找几个新房点击尝试,很容易验证这个规律。

反爬分析

相同的ip地址频繁访问同一个网页会有被封风险,本文采用fake_useragent,将随机生成的User-Agent请求头去访问网页,将减少ip封锁的风险。

代码实现

导入爬虫相关库,定义一个主函数,构建区域列表(不同区域对应不用的区域id),遍历并用requests去请求由区域参数和页码参数拼接的URL。这里将页码设置50上限,当遍历的某个房源URL长度为0(即不存在新房数据)时,直接break,让程序进行下一个区域的遍历,直至所有数据抓取完毕,程序停止。

# -*- coding = uft-8 -*-<br /># @Time : 2020/12/21 9:29 下午<br /># @Author : J哥<br /># @File : newhouse.py<br /><br />import csv<br />import time<br />import random<br />import requests<br />import traceback<br />from lxml import etree<br />from fake_useragent import UserAgent<br /><br />def main():<br /> #46:惠城区,47:仲恺区,171:惠阳区,172:大亚湾,173:博罗县,174:惠东县,175:龙门县<br /> qy_list = [46,47,171,172,173,174,175]<br /> for qy in qy_list: #遍历区域<br /> for page in range(1,50): #遍历页数<br /> url = f'http://www.fz0752.com/project/list.shtml?state=&key=&qy={qy}&area=&danjia=&func=&fea=&type=&kp=&mj=&sort=&pageNO={page}'<br /> response = requests.request("GET", url, headers = headers,timeout = 5)<br /> print(response.status_code)<br /> if response.status_code == 200:<br /> re = response.content.decode('utf-8')<br /> print("正在提取" + str(qy) +'第' + str(page) + "页")<br /> #time.sleep(random.uniform(1, 2))<br /> print("-" * 80)<br /> # print(re)<br /> parse = etree.HTML(re)<br /> get_href(parse,qy)<br /> num = ''.join(parse.xpath('//*[@id="parent-content"]/div/div[6]/div/div[1]/div[2]/div[1]/div[2]/div[1]/div[1]/a/@href'))<br /> print(len(num))<br /> if len(num) == 0:<br /> break<br /><br />if __name__ == '__main__':<br /> ua = UserAgent(verify_ssl=False)<br /> headers = {"User-Agent": ua.random}<br /> time.sleep(random.uniform(1, 2))<br /> main()<br />

发送请求,获取新房列表网页,并解析到所有新房URL,同时将新房id替换为详情信息id。在程序运行中发现有少数新房URL不一致,因此这里做了判断,修改后可以获取完整的详情信息id,并拼接出对应的URL。

def get_href(parse,qy):<br /> items = parse.xpath('//*[@id="parent-content"]/div/div[6]/div/div[1]/div[2]/div')<br /> try:<br /> for item in items:<br /> href = ''.join(item.xpath('./div[2]/div[1]/div[1]/a/@href')).strip()<br /> print("初始href为:",href)<br /> #print(len(href))<br /> if len(href) > 25:<br /> href1 = 'http://newhouse.fz0752.com/project/detail.shtml?num=' + href[52:].replace(".html","")<br /> else:<br /> href1 = 'http://newhouse.fz0752.com/project/detail.shtml?num=' + href[15:]<br /> print("详情href为:",href1)<br /> try:<br /> get_detail(href1,qy)<br /> except:<br /> pass<br /> except Exception:<br /> print(traceback.print_exc())<br />

打印结果如下:

详情信息URL找到后,定义一个函数去请求详情页数据,同时携带qy参数,最后将其保存到csv中。

def get_detail(href1,qy):<br /> time.sleep(random.uniform(1, 2))<br /> response = requests.get(href1, headers=headers,timeout = 5)<br /> if response.status_code == 200:<br /> source = response.text<br /> html = etree.HTML(source)<br />

开始解析详情页中的各个字段,这里用到xpath进行数据解析,由于需要解析的字段太多,高达41个,限于篇幅,以下仅给出部分字段解析代码。当然,其他字段解析基本一样。

#项目状态<br />try:<br /> xmzt = html.xpath('//*[@id="parent-content"]/div/div[3]/div[3]/div[1]/div[1]/text()')[0].strip()<br />except:<br /> xmzt = None<br />#项目名称<br />try:<br /> name = html.xpath('//*[@id="parent-content"]/div/div[3]/div[3]/div[1]/h1/text()')[0].strip()<br />except:<br /> name = None<br />#项目简介<br />ps = html.xpath('//*[@id="parent-content"]/div/div[3]/div[5]/div[2]/div')<br />for p in ps:<br /> try:<br /> xmjj = p.xpath('./p[1]/text()')[0].strip()<br /> except:<br /> xmjj = None<br />infos = html.xpath('//*[@id="parent-content"]/div/div[3]/div[5]/div[1]/div/table/tbody')<br />for info in infos:<br /> #行政区域<br /> try:<br /> xzqy = info.xpath('./tr[1]/td[1]/text()')[0].strip()<br /> except:<br /> xzqy = None<br /> #物业类型<br /> try:<br /> wylx = info.xpath('./tr[2]/td[1]/text()')[0].strip()<br /> except:<br /> wylx = None<br /> #销售价格<br /> try:<br /> xsjg = info.xpath('./tr[3]/td[1]/text()')[0].strip()<br /> except:<br /> xsjg = None<br /> ······<br /> data = {<br /> 'xmzt':xmzt,<br /> 'name':name,<br /> 'xzqy':xzqy,<br /> ······<br /> 'qy':qy<br /> }<br /> print(data)<br />

解析完数据后,将其置于字典中,打印结果如下:

然后追加保存为csv:

try:<br /> with open('hz_newhouse.csv', 'a', encoding='utf_8_sig', newline='') as fp:<br /> fieldnames = ['xmzt','name','xzqy',······,'qy']<br /> writer = csv.DictWriter(fp, fieldnames = fieldnames)<br /> writer.writerow(data)<br />except Exception:<br /> print(traceback.print_exc())<br />

当然,我们也可以读取csv文件,并写入Excel:

df = pd.read_csv("newhouse.csv",names=['name','xzqy','wylx',······,'state'])<br />df = df.drop_duplicates()<br />df.to_excel("newhouse.xlsx",index=False)<br />

总结

本文基于Python爬虫技术,提供了一种更直观的抓取新房数据的方法。

不建议抓取太多,容易使得服务器负载,浅尝辄止即可。

抓取网页数据 学完Python后,都能干点什么?

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-05-01 07:14

Python是一种全栈的开发语言,你如果能学好Python,前端,后端,测试,大数据分析,爬虫等这些工作你都能胜任。

当下Python有多火我不再赘述,Python有哪些作用呢?

相比其他静态编程语言,如java,c#,C++,python抓取网页文档的接口更简洁;相比其他动态脚本语言,如perl,shell,python的urllib2包提供了较为完整的访问网页文档的API。

此外,抓取网页有时候需要模拟浏览器的行为,很多网站对于生硬的爬虫抓取都是封杀的。在python里都有非常优秀的第三方包帮你搞定,如Requests,mechanize。

抓取的网页通常需要处理,比如过滤html标签,提取文本等。python的beautifulsoap提供了简洁的文档处理功能,能用极短的代码完成大部分文档的处理。

其实以上功能很多语言和工具都能做,但是用python能够干得最快,最干净。

就目前Python发展而言,Python主要有以下五大主要应用:

接下来和大家一一聊聊学完python之后可以从事哪些方面的工作:

Python Web开发工程师:我们都知道Web网站开发一直都是所有互联网公司开发的重点之一,我们离不开互联网,离不开Web技术,利用Python的Web框架可以迅速开发Web应用。

Python爬虫开发工程师:在当前信息大爆炸时代,大量的信息都通过Web来展示,为了获取这些数据,网络爬虫工程师就应运而生,除了日常的抓取数据和解析数据的需求,还能够突破普通网站常见的反爬虫机制,以及更深层次的爬虫采集算法的编写。

Python大数据工程师:在大数据时代,数据是公司的核心资产,从杂乱无章的数据中提取有价值的信息或者规律,成为了数据分析师的首要任务,而Python的工具链为这项繁重的工作提供了极高的效率支持。

Python人工智能工程师:人工智能的迅速发展将深刻改变人类社会生活、改变世界。为抢抓人工智能发展的重大战略机遇,构筑我国人工智能发展的先发优势,加快建设创新型国家和世界科技强国,当前人工智能发展进入新阶段。

Python拥有强大的脚本处理功能,它在操作Linux系统方面具有先天的优势,许多云平台、运维监控管理工具都是使用Python开发的,Python自动化运维让运维工程师的工作量减少效率提高!

当然也不是说让所有人都去追逐新技术,什么流行学什么。工作或者学习之余,学些热门技术,可以让自己保持敏锐度和竞争力,因为说不好什么时候这些热门技术就成了你的饭碗。 查看全部

抓取网页数据 学完Python后,都能干点什么?

Python是一种全栈的开发语言,你如果能学好Python,前端,后端,测试,大数据分析,爬虫等这些工作你都能胜任。

当下Python有多火我不再赘述,Python有哪些作用呢?

相比其他静态编程语言,如java,c#,C++,python抓取网页文档的接口更简洁;相比其他动态脚本语言,如perl,shell,python的urllib2包提供了较为完整的访问网页文档的API。

此外,抓取网页有时候需要模拟浏览器的行为,很多网站对于生硬的爬虫抓取都是封杀的。在python里都有非常优秀的第三方包帮你搞定,如Requests,mechanize。

抓取的网页通常需要处理,比如过滤html标签,提取文本等。python的beautifulsoap提供了简洁的文档处理功能,能用极短的代码完成大部分文档的处理。

其实以上功能很多语言和工具都能做,但是用python能够干得最快,最干净。

就目前Python发展而言,Python主要有以下五大主要应用:

接下来和大家一一聊聊学完python之后可以从事哪些方面的工作:

Python Web开发工程师:我们都知道Web网站开发一直都是所有互联网公司开发的重点之一,我们离不开互联网,离不开Web技术,利用Python的Web框架可以迅速开发Web应用。

Python爬虫开发工程师:在当前信息大爆炸时代,大量的信息都通过Web来展示,为了获取这些数据,网络爬虫工程师就应运而生,除了日常的抓取数据和解析数据的需求,还能够突破普通网站常见的反爬虫机制,以及更深层次的爬虫采集算法的编写。

Python大数据工程师:在大数据时代,数据是公司的核心资产,从杂乱无章的数据中提取有价值的信息或者规律,成为了数据分析师的首要任务,而Python的工具链为这项繁重的工作提供了极高的效率支持。

Python人工智能工程师:人工智能的迅速发展将深刻改变人类社会生活、改变世界。为抢抓人工智能发展的重大战略机遇,构筑我国人工智能发展的先发优势,加快建设创新型国家和世界科技强国,当前人工智能发展进入新阶段。

Python拥有强大的脚本处理功能,它在操作Linux系统方面具有先天的优势,许多云平台、运维监控管理工具都是使用Python开发的,Python自动化运维让运维工程师的工作量减少效率提高!

当然也不是说让所有人都去追逐新技术,什么流行学什么。工作或者学习之余,学些热门技术,可以让自己保持敏锐度和竞争力,因为说不好什么时候这些热门技术就成了你的饭碗。

推荐收藏 | 这30个高质量的数据集网站,你必须要试试!

网站优化 • 优采云 发表了文章 • 0 个评论 • 385 次浏览 • 2022-05-01 07:12

导言

当我们做数据分析的时候,可以通过手动抓取一些数据,比如爬虫。但是往往有些数据抓取不到,还有一些人根本不会爬虫,并且学习爬虫的时间成本也较高,这时候,为了更加方便我们快捷的学习可视化和数据分析的知识,我们的时间应该投入到后续的研究而不是数据的获取,所以今天给大家推荐30个常用的数据搜集网站,解决数据获取问题。

一、数据查询网站

1、企业产生的用户数据

百度指数:

阿里指数:

TBI 腾讯浏览指数:

新浪微博指数:

2 、数据平台购买数据

数据堂:

国云数据市场:

贵阳大数据交易所:

3 、政府/ 机构公开的数据

中华人民共和国国家统计局数据:

世界银行公开数据:

联合国数据:

纳斯达克:

4 、 数据管理咨询公司

麦肯锡:

埃森哲:

艾瑞咨询:

二、简单通用数据集

1、中国国家统计局

()

2、美国政府公开数据

( )

这是美国政府公开数据的所在地,该站点包含了超过19万的数据点。这些数据集不同于气候、教育、能源、金融和更多领域的数据。

3、印度政府公开数据

()

这是印度政府公开数据的所在地,通过各种行业、气候、医疗保健等来寻找数据,你可以在这里找到一些灵感。根据你居住的国家的不同,你也可以从其他一些网站上浏览类似的网站。

4.World Bank

( )

世界银行的开放数据。该平台提供 Open Data Catalog,世界发展指数,教育指数等几个工具。

5. RBI

( )

印度储备银行提供的数据。这包括了货币市场操作、收支平衡、银行使用和一些产品的几个指标。

三、大型数据集

1、AmazonWebService-datasets

()

Amazon提供了一些大数据集,可以在他们的平台上使用,也可以在本地计算机上使用。您还可以通过EMR使用EC2和Hadoop来分析云中的数据。在亚马逊上流行的数据集包括完整的安然电子邮件数据集,Google Books n-gram,NASA NEX 数据集,百万歌曲数据集等。

2、Google datasets

()

Google 提供了一些数据集作为其 Big Query 工具的一部分。包括 GitHub 公共资料库的数据,Hacker News 的所有故事和评论

3、Youtube-labeled-Video-Dataset

()

四、预测建模与机器学习数据集

1、UC-Machine-Learning-Repository

()

UCI机器学习库显然是最著名的数据存储库。如果您正在寻找与机器学习存储库相关的数据集,通常是首选的地方。这些数据集包括了各种各样的数据集,从像Iris和泰坦尼克这样的流行数据集到最近的贡献,比如空气质量和GPS轨迹。存储库包含超过350个与域名类似的数据集(分类/回归)。您可以使用这些过滤器来确定您需要的数据集。

2、Kaggle

Kaggle提出了一个平台,人们可以贡献数据集,其他社区成员可以投票并运行内核/脚本。他们总共有超过350个数据集——有超过200个特征数据集。虽然一些最初的数据集通常出现在其他地方,但我在平台上看到了一些有趣的数据集,而不是在其他地方出现。与新的数据集一起,界面的另一个好处是,您可以在相同的界面上看到来自社区成员的脚本和问题。

3、Analytics-Vidhya

()

您可以从我们的实践问题和黑客马拉松问题中参与和下载数据集。问题数据集基于真实的行业问题,并且相对较小,因为它们意味着2 - 7天的黑客马拉松。

4、Quandl

Quandl 通过起网站、API 或一些工具的直接集成提供了不同来源的财务、经济和替代数据。他们的数据集分为开放和付费。所有开放数据集为免费,但高级数据集需要付费。通过搜索仍然可以在平台上找到优质数据集。例如,来自印度的证券交易所数据是免费的。

5、Past KDD Cups

()

KDD Cup 是 ACM Special Interest Group 组织的年度数据挖掘和知识发现竞赛。

五、图像分类数据集

1、The MNIST Database

( )

最流行的图像识别数据集,使用手写数字。它包括6万个示例和1万个示例的测试集。这通常是第一个进行图像识别的数据集。

2、Chars74K

( )

这里是下一阶段的进化,如果你已经通过了手写的数字。该数据集包括自然图像中的字符识别。数据集包含74,000个图像,因此数据集的名称。

3、Frontal Face Images

( )

如果你已经完成了前两个项目,并且能够识别数字和字符,这是图像识别中的下一个挑战级别——正面人脸图像。这些图像是由CMU & MIT收集的,排列在四个文件夹中。

4、ImageNet

( )

现在是时候构建一些通用的东西了。根据WordNet层次结构组织的图像数据库(目前仅为名词)。层次结构的每个节点都由数百个图像描述。目前,该集合平均每个节点有超过500个图像(而且还在增加)。

六、文本分类数据集

1、Spam – Non Spam

()

区分短信是否为垃圾邮件是一个有趣的问题。你需要构建一个分类器将短信进行分类。

2、Twitter Sentiment Analysis

()

该数据集包含 1578627 个分类推文,每行被标记为1的积极情绪,0位负面情绪。数据依次基于 Kaggle 比赛和 Nick Sanders 的分析。

3、Movie Review Data

()

这个网站提供了一系列的电影评论文件,这些文件标注了他们的总体情绪极性(正面或负面)或主观评价(例如,“两个半明星”)和对其主观性地位(主观或客观)或极性的标签。

七、推荐引擎数据集

1、MovieLens

( )

MovieLens 是一个帮助人们查找电影的网站。它有成千上万的注册用户。他们进行自动内容推荐,推荐界面,基于标签的推荐页面等在线实验。这些数据集可供下载,可用于创建自己的推荐系统。

2、Jester

(~goldberg/jester-data/)

在线笑话推荐系统。 查看全部

推荐收藏 | 这30个高质量的数据集网站,你必须要试试!

导言

当我们做数据分析的时候,可以通过手动抓取一些数据,比如爬虫。但是往往有些数据抓取不到,还有一些人根本不会爬虫,并且学习爬虫的时间成本也较高,这时候,为了更加方便我们快捷的学习可视化和数据分析的知识,我们的时间应该投入到后续的研究而不是数据的获取,所以今天给大家推荐30个常用的数据搜集网站,解决数据获取问题。

一、数据查询网站

1、企业产生的用户数据

百度指数:

阿里指数:

TBI 腾讯浏览指数:

新浪微博指数:

2 、数据平台购买数据

数据堂:

国云数据市场:

贵阳大数据交易所:

3 、政府/ 机构公开的数据

中华人民共和国国家统计局数据:

世界银行公开数据:

联合国数据:

纳斯达克:

4 、 数据管理咨询公司

麦肯锡:

埃森哲:

艾瑞咨询:

二、简单通用数据集

1、中国国家统计局

()

2、美国政府公开数据

( )

这是美国政府公开数据的所在地,该站点包含了超过19万的数据点。这些数据集不同于气候、教育、能源、金融和更多领域的数据。

3、印度政府公开数据

()

这是印度政府公开数据的所在地,通过各种行业、气候、医疗保健等来寻找数据,你可以在这里找到一些灵感。根据你居住的国家的不同,你也可以从其他一些网站上浏览类似的网站。

4.World Bank

( )

世界银行的开放数据。该平台提供 Open Data Catalog,世界发展指数,教育指数等几个工具。

5. RBI

( )

印度储备银行提供的数据。这包括了货币市场操作、收支平衡、银行使用和一些产品的几个指标。

三、大型数据集

1、AmazonWebService-datasets

()

Amazon提供了一些大数据集,可以在他们的平台上使用,也可以在本地计算机上使用。您还可以通过EMR使用EC2和Hadoop来分析云中的数据。在亚马逊上流行的数据集包括完整的安然电子邮件数据集,Google Books n-gram,NASA NEX 数据集,百万歌曲数据集等。

2、Google datasets

()

Google 提供了一些数据集作为其 Big Query 工具的一部分。包括 GitHub 公共资料库的数据,Hacker News 的所有故事和评论

3、Youtube-labeled-Video-Dataset

()

四、预测建模与机器学习数据集

1、UC-Machine-Learning-Repository

()

UCI机器学习库显然是最著名的数据存储库。如果您正在寻找与机器学习存储库相关的数据集,通常是首选的地方。这些数据集包括了各种各样的数据集,从像Iris和泰坦尼克这样的流行数据集到最近的贡献,比如空气质量和GPS轨迹。存储库包含超过350个与域名类似的数据集(分类/回归)。您可以使用这些过滤器来确定您需要的数据集。

2、Kaggle

Kaggle提出了一个平台,人们可以贡献数据集,其他社区成员可以投票并运行内核/脚本。他们总共有超过350个数据集——有超过200个特征数据集。虽然一些最初的数据集通常出现在其他地方,但我在平台上看到了一些有趣的数据集,而不是在其他地方出现。与新的数据集一起,界面的另一个好处是,您可以在相同的界面上看到来自社区成员的脚本和问题。

3、Analytics-Vidhya

()

您可以从我们的实践问题和黑客马拉松问题中参与和下载数据集。问题数据集基于真实的行业问题,并且相对较小,因为它们意味着2 - 7天的黑客马拉松。

4、Quandl

Quandl 通过起网站、API 或一些工具的直接集成提供了不同来源的财务、经济和替代数据。他们的数据集分为开放和付费。所有开放数据集为免费,但高级数据集需要付费。通过搜索仍然可以在平台上找到优质数据集。例如,来自印度的证券交易所数据是免费的。

5、Past KDD Cups

()

KDD Cup 是 ACM Special Interest Group 组织的年度数据挖掘和知识发现竞赛。

五、图像分类数据集

1、The MNIST Database

( )

最流行的图像识别数据集,使用手写数字。它包括6万个示例和1万个示例的测试集。这通常是第一个进行图像识别的数据集。

2、Chars74K

( )

这里是下一阶段的进化,如果你已经通过了手写的数字。该数据集包括自然图像中的字符识别。数据集包含74,000个图像,因此数据集的名称。

3、Frontal Face Images

( )

如果你已经完成了前两个项目,并且能够识别数字和字符,这是图像识别中的下一个挑战级别——正面人脸图像。这些图像是由CMU & MIT收集的,排列在四个文件夹中。

4、ImageNet

( )

现在是时候构建一些通用的东西了。根据WordNet层次结构组织的图像数据库(目前仅为名词)。层次结构的每个节点都由数百个图像描述。目前,该集合平均每个节点有超过500个图像(而且还在增加)。

六、文本分类数据集

1、Spam – Non Spam

()

区分短信是否为垃圾邮件是一个有趣的问题。你需要构建一个分类器将短信进行分类。

2、Twitter Sentiment Analysis

()

该数据集包含 1578627 个分类推文,每行被标记为1的积极情绪,0位负面情绪。数据依次基于 Kaggle 比赛和 Nick Sanders 的分析。

3、Movie Review Data

()

这个网站提供了一系列的电影评论文件,这些文件标注了他们的总体情绪极性(正面或负面)或主观评价(例如,“两个半明星”)和对其主观性地位(主观或客观)或极性的标签。

七、推荐引擎数据集

1、MovieLens

( )

MovieLens 是一个帮助人们查找电影的网站。它有成千上万的注册用户。他们进行自动内容推荐,推荐界面,基于标签的推荐页面等在线实验。这些数据集可供下载,可用于创建自己的推荐系统。

2、Jester

(~goldberg/jester-data/)

在线笑话推荐系统。

网站数据分析的内容有哪些

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-04-22 07:53

当我们网站优化到后期,关键词排名提升上去,网站有了权重,有了流量,我们想要让网站更稳定的提升上去,就需要做好网站的数据分析工作,那么网站数据分析的内容有哪些呢?对于这方面很多人不是很了解,今天seo知识网就为大家详细介绍一下。

网站数据分析的内容有哪些?主要有以下几点内容。

一、网站关键字排名

网站关键词排名基本上我们每次工作开始时,都会例行检查一下,看看经过这段时间的优化,网站关键词排名是提升还是降低,是否有出现大的波动,从而判断网站目前的状况。

二、搜索引擎爬取网站的情况

网页访问的內容的系统日志被放到大家网址的系统日志文件夹名称中,假如应用云虚拟主机,立即根据FTP开展免费下载,相互配合日志分析系统专用工具(亿光年、逆火开展剖析)剖析网址被搜搜索引擎页的內容的状况,立即调节网址內部的设定和连接合理布局。

三、网站的收录情况

看看网站的收录情况,收录是减少还是减低,通常我们网站有权重后,搜索引擎抓取频次都会比较高,网站收录情况也会出现波动,如果每天收录都在降低,那么可能就是因为网站被惩罚,导致收录降低,我们需要寻找原因,进行整改。而正常的情况,通常收录是会缓慢增加。

四、用户访问情况

通常百度统计,看看用户的访问情况,哪些页面跳出率高,哪些页面停留时间长,根据这些数据对网站进行相应的调整优化,从而提升用户体验度,增加用户停留时间。

以上就是【网站数据分析的内容有哪些】的介绍,希望对大家有所帮助。如果大家还想要了解更多seo优化知识,可以关注和收藏我们,我们会不定期更新网站建设、seo优化、网站优化方案、seo工具、seo外包、网络推广等方面知识,供大家参考、了解。 查看全部

当我们网站优化到后期,关键词排名提升上去,网站有了权重,有了流量,我们想要让网站更稳定的提升上去,就需要做好网站的数据分析工作,那么网站数据分析的内容有哪些呢?对于这方面很多人不是很了解,今天seo知识网就为大家详细介绍一下。

网站数据分析的内容有哪些?主要有以下几点内容。

一、网站关键字排名

网站关键词排名基本上我们每次工作开始时,都会例行检查一下,看看经过这段时间的优化,网站关键词排名是提升还是降低,是否有出现大的波动,从而判断网站目前的状况。

二、搜索引擎爬取网站的情况

网页访问的內容的系统日志被放到大家网址的系统日志文件夹名称中,假如应用云虚拟主机,立即根据FTP开展免费下载,相互配合日志分析系统专用工具(亿光年、逆火开展剖析)剖析网址被搜搜索引擎页的內容的状况,立即调节网址內部的设定和连接合理布局。

三、网站的收录情况

看看网站的收录情况,收录是减少还是减低,通常我们网站有权重后,搜索引擎抓取频次都会比较高,网站收录情况也会出现波动,如果每天收录都在降低,那么可能就是因为网站被惩罚,导致收录降低,我们需要寻找原因,进行整改。而正常的情况,通常收录是会缓慢增加。

四、用户访问情况

通常百度统计,看看用户的访问情况,哪些页面跳出率高,哪些页面停留时间长,根据这些数据对网站进行相应的调整优化,从而提升用户体验度,增加用户停留时间。

以上就是【网站数据分析的内容有哪些】的介绍,希望对大家有所帮助。如果大家还想要了解更多seo优化知识,可以关注和收藏我们,我们会不定期更新网站建设、seo优化、网站优化方案、seo工具、seo外包、网络推广等方面知识,供大家参考、了解。

2021年巨热门的Python爬虫框架大推荐

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-04-22 07:53

Python爬虫框架的优点真是说也说不完,它可以让程序员以更少的代码实现自定义功能,还可以将更多的精力集中在业务逻辑上,更加的轻松便利。因此本文将为大家推荐十款常见且好用的爬虫框架。

一、Scrapy

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。可以应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序中。。用这个框架可以轻松爬下来如亚马逊商品信息之类的数据。

二、PySpider

pyspider 是一个用python实现的功能强大的网络爬虫系统,能在浏览器界面上进行脚本的编写,功能的调度和爬取结果的实时查看,后端使用常用的数据库进行爬取结果的存储,还能定时设置任务与任务优先级等。

三、Crawley

Crawley可以高速爬取对应网站的内容,支持关系和非关系数据库,数据可以导出为JSON、XML等。

四、Portia

Portia是一个开源可视化爬虫工具,可让您在不需要任何编程知识的情况下爬取网站!简单地注释您感兴趣的页面,Portia将创建一个蜘蛛来从类似的页面提取数据。

五、Newspaper

Newspaper可以用来提取新闻、文章和内容分析。使用多线程,支持10多种语言等。

六、Beautiful Soup

Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式.Beautiful Soup会帮你节省数小时甚至数天的工作时间。

七、Grab

Grab是一个用于构建Web刮板的Python框架。借助Grab,您可以构建各种复杂的网页抓取工具,从简单的5行脚本到处理数百万个网页的复杂异步网站抓取工具。Grab提供一个API用于执行网络请求和处理接收到的内容,例如与HTML文档的DOM树进行交互。

八、Cola

Cola是一个分布式的爬虫框架,对于用户来说,只需编写几个特定的函数,而无需关注分布式运行的细节。任务会自动分配到多台机器上,整个过程对用户是透明的。

九、selenium

Selenium 是自动化测试工具。它支持各种浏览器,包括 Chrome,Safari,Firefox 等主流界面式浏览器,如果在这些浏览器里面安装一个 Selenium 的插件,可以方便地实现Web界面的测试. Selenium 支持浏览器驱动。

Selenium支持多种语言开发,比如 Java,C,Ruby等等,PhantomJS 用来渲染解析JS,Selenium 用来驱动以及与 Python 的对接,Python 进行后期的处理。

十、Python-goose框架

Python-goose框架可提取的信息包括:

1.文章主体内容

2.文章主要图片

3.文章中嵌入的任何Youtube/Vimeo视频

4.元描述5.元标签

以上就是十款十款Python爬虫框架大推荐 ,希望可以帮助大家在工作中更加方便高效。 查看全部

2021年巨热门的Python爬虫框架大推荐

Python爬虫框架的优点真是说也说不完,它可以让程序员以更少的代码实现自定义功能,还可以将更多的精力集中在业务逻辑上,更加的轻松便利。因此本文将为大家推荐十款常见且好用的爬虫框架。

一、Scrapy

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。可以应用在包括数据挖掘,信息处理或存储历史数据等一系列的程序中。。用这个框架可以轻松爬下来如亚马逊商品信息之类的数据。

二、PySpider

pyspider 是一个用python实现的功能强大的网络爬虫系统,能在浏览器界面上进行脚本的编写,功能的调度和爬取结果的实时查看,后端使用常用的数据库进行爬取结果的存储,还能定时设置任务与任务优先级等。

三、Crawley

Crawley可以高速爬取对应网站的内容,支持关系和非关系数据库,数据可以导出为JSON、XML等。

四、Portia

Portia是一个开源可视化爬虫工具,可让您在不需要任何编程知识的情况下爬取网站!简单地注释您感兴趣的页面,Portia将创建一个蜘蛛来从类似的页面提取数据。

五、Newspaper

Newspaper可以用来提取新闻、文章和内容分析。使用多线程,支持10多种语言等。

六、Beautiful Soup

Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式.Beautiful Soup会帮你节省数小时甚至数天的工作时间。

七、Grab

Grab是一个用于构建Web刮板的Python框架。借助Grab,您可以构建各种复杂的网页抓取工具,从简单的5行脚本到处理数百万个网页的复杂异步网站抓取工具。Grab提供一个API用于执行网络请求和处理接收到的内容,例如与HTML文档的DOM树进行交互。

八、Cola

Cola是一个分布式的爬虫框架,对于用户来说,只需编写几个特定的函数,而无需关注分布式运行的细节。任务会自动分配到多台机器上,整个过程对用户是透明的。

九、selenium

Selenium 是自动化测试工具。它支持各种浏览器,包括 Chrome,Safari,Firefox 等主流界面式浏览器,如果在这些浏览器里面安装一个 Selenium 的插件,可以方便地实现Web界面的测试. Selenium 支持浏览器驱动。

Selenium支持多种语言开发,比如 Java,C,Ruby等等,PhantomJS 用来渲染解析JS,Selenium 用来驱动以及与 Python 的对接,Python 进行后期的处理。

十、Python-goose框架

Python-goose框架可提取的信息包括:

1.文章主体内容

2.文章主要图片

3.文章中嵌入的任何Youtube/Vimeo视频

4.元描述5.元标签

以上就是十款十款Python爬虫框架大推荐 ,希望可以帮助大家在工作中更加方便高效。

[按键精灵][协议抓包]抓取某人微博的内容

网站优化 • 优采云 发表了文章 • 0 个评论 • 276 次浏览 • 2022-04-22 07:53

通常我会直接用url.get命令获取网页源码,然后从源码中提取我们需要的内容,但是我们这次的案例确实不能提取。

TracePrint url.get("https://weibo.com/u/6074356560")

运行此行代码提取的网页源码并不是网页上显示的内容,而是包含了部分javascript代码的,也就是页面内容还需js加载出来,这种情况我们就需要通过抓包来找到网页的内容。

我们来说一下具体的操作步骤:

①准备抓包工具,我选择使用浏览器自带的调试工具,打开浏览器按F12键就可以开启调试工具。

每个浏览器都有自己的调试工具,基本上功能和样式都差不多,大家有什么浏览器就用什么浏览器。

②设置好调试工具初始状态。

打开网络抓包(network),清空抓包列表的内容,具体操作看下图。

③开始抓包

在调试工具准备好后,刷新一下网页,让网页重新加载,会看到有数据包被抓取出来了。

④找到我们想要的数据包

抓取的数据很多,一条条找比较费劲,在左侧有一个搜索框,我们利用搜索功能,找到我们想要的内容,那么到底搜索什么内容呢?

每一个页面要搜索的内容都不一样,以我们今天这个获取微博内容为例,想要抓取的是微博内容,那么就选取页面微博内容中的一些关键词。

可以看到有一条搜索结果,这个就是我们想要抓取的部分,有的时候可能会有多条搜索结果。

⑤数据初步分析:

点开上一步的搜索结果,右侧出现这条协议的数据,我们这个例子是返回一个json数据。

一般我会把这个json数据复制出来,看看是不是包含全部想要的内容,这个我已经看过了,是我想要的。

⑥协议分析和提取。

点一下协议头,看看协议部分:

协议部分内容很长,只截取部分展示:

对于协议头这里,我会关注这么几个:

a. 请求url

b. 请求方式c. cookied. user-agente. 请求的参数

⑦把协议部分得到的内容,写到post或者get命令里面

Import "cjson.lua"Dim url1 = "https://weibo.com/ajax/statuse ... ot%3B Dim hader = "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36" //协议头UADim cookie="SINAGLOBAL=9136586994469.588.1644929595244; SUB=_2AkMVfL5qf8NxqwFRmP0cxWvmbotzyQzEieKjIE-xJRMxHRl-yT_nqkEktRB6PvyQhZiuc5bq2rXhJxpLi8XsJokdU_pg; SUBP=0033WrSXqPxfM72-Ws9jqgMF55529P9D9WWgS4MF5LO004-Z0gge_VnZ; UOR=bbs.anjian.com,widget.weibo.com,bbs.anjian.com; XSRF-TOKEN=56GL5F3PPUReGiB1GUXowHgk; WBPSESS=lGn6cRy34B6AsqM-wzgd2KNi64TT4SnOOf25OUUOC6Y2tgCD1eBH7am3nSNjI_XiXHjlvpFQ0A6XVONSR-M5M9PehTm9-8ao2AL6ZCZIcHpHu3kokZgURr-p4WdGoAyu4ZrMspBEvySuZV2OmiptOWGd5QgGxhHCL09ovFrSBsY=; _s_tentry=weibo.com; Apache=3154924384350.295.1650201395939; ULV=1650201395947:7:2:1:3154924384350.295.1650201395939:1649471644818"Dim date1 = {"url":url1,"code":"utf-8", "cookie":cookie, "header":{"User-Agent":hader,"content-type":"application/json"}}Dim ret = Url.Httpget(date1)TracePrint retDim table=cjson.Decode(ret)TracePrint len(table["data"]["list"])For i = 1 To Len(table["data"]["list"]) TracePrint table["data"]["list"]["text"]Next

对于单独一个页面的抓取,以及脚本提取代码就这些,但是如果想要有一些通用性,就需要一些分析能力了。

比如:案例中的请求url

uid=6074356560&page=1&feature=0

在网址中有两个很重要的参数:

uid:微博个人id号参数

page:页码,显示第1页内容填1,显示第2页内容填2

在知道这两个参数以后,就可以做一些延展:

比如更换uid,获取不同人的微博内容。

递增page页码,可以遍历一个人的所有微博内容。

这一步就需要大家有分析能力,根据不同网址想到不同的功能。

本期就是一个最简单的网页抓包案例,想要系统学习去搜索一下tcp/ip协议,工具方面网页抓包还可以用fiddler,app抓包可以用小黄鸟(httpcanary) 查看全部

通常我会直接用url.get命令获取网页源码,然后从源码中提取我们需要的内容,但是我们这次的案例确实不能提取。

TracePrint url.get("https://weibo.com/u/6074356560";)

运行此行代码提取的网页源码并不是网页上显示的内容,而是包含了部分javascript代码的,也就是页面内容还需js加载出来,这种情况我们就需要通过抓包来找到网页的内容。

我们来说一下具体的操作步骤:

①准备抓包工具,我选择使用浏览器自带的调试工具,打开浏览器按F12键就可以开启调试工具。

每个浏览器都有自己的调试工具,基本上功能和样式都差不多,大家有什么浏览器就用什么浏览器。

②设置好调试工具初始状态。

打开网络抓包(network),清空抓包列表的内容,具体操作看下图。

③开始抓包

在调试工具准备好后,刷新一下网页,让网页重新加载,会看到有数据包被抓取出来了。

④找到我们想要的数据包

抓取的数据很多,一条条找比较费劲,在左侧有一个搜索框,我们利用搜索功能,找到我们想要的内容,那么到底搜索什么内容呢?

每一个页面要搜索的内容都不一样,以我们今天这个获取微博内容为例,想要抓取的是微博内容,那么就选取页面微博内容中的一些关键词。

可以看到有一条搜索结果,这个就是我们想要抓取的部分,有的时候可能会有多条搜索结果。

⑤数据初步分析:

点开上一步的搜索结果,右侧出现这条协议的数据,我们这个例子是返回一个json数据。

一般我会把这个json数据复制出来,看看是不是包含全部想要的内容,这个我已经看过了,是我想要的。

⑥协议分析和提取。

点一下协议头,看看协议部分:

协议部分内容很长,只截取部分展示:

对于协议头这里,我会关注这么几个:

a. 请求url

b. 请求方式c. cookied. user-agente. 请求的参数

⑦把协议部分得到的内容,写到post或者get命令里面

Import "cjson.lua"Dim url1 = "https://weibo.com/ajax/statuse ... ot%3B Dim hader = "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36" //协议头UADim cookie="SINAGLOBAL=9136586994469.588.1644929595244; SUB=_2AkMVfL5qf8NxqwFRmP0cxWvmbotzyQzEieKjIE-xJRMxHRl-yT_nqkEktRB6PvyQhZiuc5bq2rXhJxpLi8XsJokdU_pg; SUBP=0033WrSXqPxfM72-Ws9jqgMF55529P9D9WWgS4MF5LO004-Z0gge_VnZ; UOR=bbs.anjian.com,widget.weibo.com,bbs.anjian.com; XSRF-TOKEN=56GL5F3PPUReGiB1GUXowHgk; WBPSESS=lGn6cRy34B6AsqM-wzgd2KNi64TT4SnOOf25OUUOC6Y2tgCD1eBH7am3nSNjI_XiXHjlvpFQ0A6XVONSR-M5M9PehTm9-8ao2AL6ZCZIcHpHu3kokZgURr-p4WdGoAyu4ZrMspBEvySuZV2OmiptOWGd5QgGxhHCL09ovFrSBsY=; _s_tentry=weibo.com; Apache=3154924384350.295.1650201395939; ULV=1650201395947:7:2:1:3154924384350.295.1650201395939:1649471644818"Dim date1 = {"url":url1,"code":"utf-8", "cookie":cookie, "header":{"User-Agent":hader,"content-type":"application/json"}}Dim ret = Url.Httpget(date1)TracePrint retDim table=cjson.Decode(ret)TracePrint len(table["data"]["list"])For i = 1 To Len(table["data"]["list"]) TracePrint table["data"]["list"]["text"]Next

对于单独一个页面的抓取,以及脚本提取代码就这些,但是如果想要有一些通用性,就需要一些分析能力了。

比如:案例中的请求url

uid=6074356560&page=1&feature=0

在网址中有两个很重要的参数:

uid:微博个人id号参数

page:页码,显示第1页内容填1,显示第2页内容填2

在知道这两个参数以后,就可以做一些延展:

比如更换uid,获取不同人的微博内容。

递增page页码,可以遍历一个人的所有微博内容。

这一步就需要大家有分析能力,根据不同网址想到不同的功能。

本期就是一个最简单的网页抓包案例,想要系统学习去搜索一下tcp/ip协议,工具方面网页抓包还可以用fiddler,app抓包可以用小黄鸟(httpcanary)

抓取网页数据( 利用Python模块来爬网数据,实现爬网数据的需求)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-04-20 05:40

利用Python模块来爬网数据,实现爬网数据的需求)

从 网站

抓取数据的 3 种最佳方法

在过去几年中,抓取数据的需求越来越大。爬取的数据可用于不同领域的评估或预测。在这里,我想谈谈我们可以采取的三种方法来从 网站 爬取数据。

1.使用 网站API

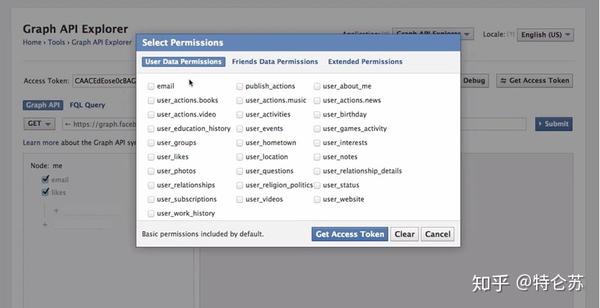

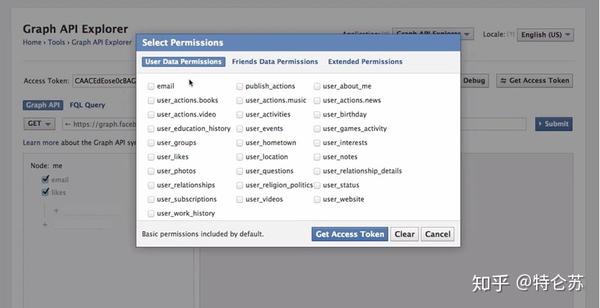

许多大型社交媒体网站,例如 Facebook、Twitter、Instagram、StackOverflow,都提供 API 供用户访问他们的数据。有时,您可以选择官方 API 来获取结构化数据。如下面 Facebook Graph API 所示,您需要选择要查询的字段,然后对数据进行排序、执行 URL 查找、发出请求等。

2.构建自己的爬虫

但是,并非所有 网站 都向用户提供 API。部分网站由于技术限制或其他原因拒绝提供任何公共API。有人可能会提出 RSS 提要,但由于使用受限,我不会建议或评论它们。在这种情况下,我想讨论的是,我们可以构建自己的爬虫来处理这种情况。

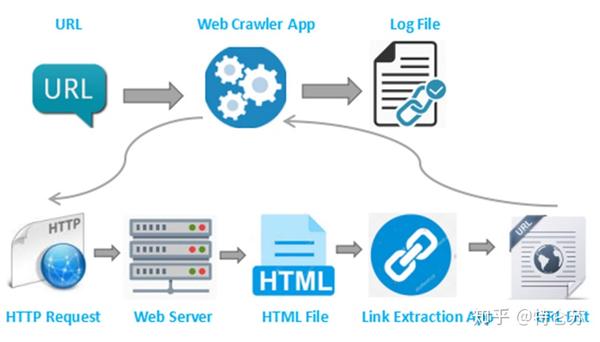

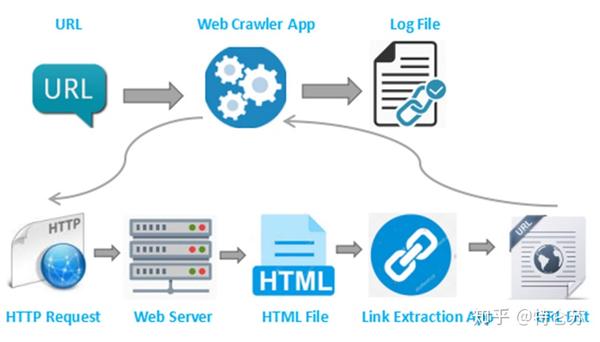

爬虫是如何工作的?换句话说,爬虫是一种生成可以由提取器提供的 URL 列表的方法。爬虫可以定义为查找 URL 的工具。首先,您为爬虫提供一个要启动的网页,它们会跟随该页面上的所有链接。然后该过程将继续循环。

然后我们可以继续构建我们自己的爬虫。众所周知,Python 是一种开源编程语言,您可以找到许多有用的函数库。这里我推荐 BeautifulSoup(一个 Python 库),因为它易于使用并且具有许多直观的字符。更准确地说,我将使用两个 Python 模块来抓取数据。

BeautifulSoup 无法为我们获取该页面。这就是我将 urllib2 与 BeautifulSoup 库一起使用的原因。然后我们需要处理 HTML 标记以找到页面标记和右表中的所有链接。之后,遍历每一行 (tr) 并将 tr (td) 的每个元素分配给一个变量并将其附加到列表中。先看一下表格的HTML结构(表格头信息我就不提取了)。

通过采用这种方法,您的爬虫是定制的。它可以处理API提取中遇到的一些困难。您可以使用代理来防止它被某些 网站 等阻止。整个过程在您的控制范围内。这种方法对于具有编码技能的人应该是有意义的。您抓取的数据框应如下图所示。

3.使用现成的爬虫工具

但是,以编程方式自行抓取网络网站 可能会很耗时。对于没有任何编码技能的人来说,这将是一项艰巨的任务。因此,我想介绍一些爬虫工具。

优采云采集器

一个整合网页数据采集、移动互联网数据和API接口服务(包括数据爬虫、数据优化、数据挖掘、数据存储、数据备份)等服务的数据采集工具,连续6年位居互联网数据采集软件排行榜第一,截至2021年,全球用户数已突破300万。

八分法

优采云海外版,2016年3月在美国洛杉矶上线,两年内在英文市场取得了较高的市场占有率,深耕北美、欧洲、日本等市场目前有英文、日文、法文、德文、西班牙文等多种版本。 查看全部

抓取网页数据(

利用Python模块来爬网数据,实现爬网数据的需求)

从 网站

抓取数据的 3 种最佳方法

在过去几年中,抓取数据的需求越来越大。爬取的数据可用于不同领域的评估或预测。在这里,我想谈谈我们可以采取的三种方法来从 网站 爬取数据。

1.使用 网站API

许多大型社交媒体网站,例如 Facebook、Twitter、Instagram、StackOverflow,都提供 API 供用户访问他们的数据。有时,您可以选择官方 API 来获取结构化数据。如下面 Facebook Graph API 所示,您需要选择要查询的字段,然后对数据进行排序、执行 URL 查找、发出请求等。

2.构建自己的爬虫

但是,并非所有 网站 都向用户提供 API。部分网站由于技术限制或其他原因拒绝提供任何公共API。有人可能会提出 RSS 提要,但由于使用受限,我不会建议或评论它们。在这种情况下,我想讨论的是,我们可以构建自己的爬虫来处理这种情况。

爬虫是如何工作的?换句话说,爬虫是一种生成可以由提取器提供的 URL 列表的方法。爬虫可以定义为查找 URL 的工具。首先,您为爬虫提供一个要启动的网页,它们会跟随该页面上的所有链接。然后该过程将继续循环。

然后我们可以继续构建我们自己的爬虫。众所周知,Python 是一种开源编程语言,您可以找到许多有用的函数库。这里我推荐 BeautifulSoup(一个 Python 库),因为它易于使用并且具有许多直观的字符。更准确地说,我将使用两个 Python 模块来抓取数据。

BeautifulSoup 无法为我们获取该页面。这就是我将 urllib2 与 BeautifulSoup 库一起使用的原因。然后我们需要处理 HTML 标记以找到页面标记和右表中的所有链接。之后,遍历每一行 (tr) 并将 tr (td) 的每个元素分配给一个变量并将其附加到列表中。先看一下表格的HTML结构(表格头信息我就不提取了)。

通过采用这种方法,您的爬虫是定制的。它可以处理API提取中遇到的一些困难。您可以使用代理来防止它被某些 网站 等阻止。整个过程在您的控制范围内。这种方法对于具有编码技能的人应该是有意义的。您抓取的数据框应如下图所示。

3.使用现成的爬虫工具

但是,以编程方式自行抓取网络网站 可能会很耗时。对于没有任何编码技能的人来说,这将是一项艰巨的任务。因此,我想介绍一些爬虫工具。

优采云采集器

一个整合网页数据采集、移动互联网数据和API接口服务(包括数据爬虫、数据优化、数据挖掘、数据存储、数据备份)等服务的数据采集工具,连续6年位居互联网数据采集软件排行榜第一,截至2021年,全球用户数已突破300万。

八分法

优采云海外版,2016年3月在美国洛杉矶上线,两年内在英文市场取得了较高的市场占有率,深耕北美、欧洲、日本等市场目前有英文、日文、法文、德文、西班牙文等多种版本。

抓取网页数据(Python3:用Python3.检测不到正确的编码,解决思路)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-04-15 08:06

您好,首先,sys.setdefaultencoding 是邪恶的。

其次,不使用 Requests 就不要去看文档,不要乱来。

如果 Requests 无法检测到正确的编码,那么你告诉它什么是正确的:

response.encoding = 'gbk'

打印响应.文本

原创内容在response.content、bytes中,你可以随意处理。

绝对不需要为单个请求使用 Session。直接做 requests.get(xxx) 。

最后,如果您不知道如何处理错误编码的字符串,或者使用 Python 3.x,而不是 Shotgun 编程,请考虑一下。

以下是 Python 3。Python 2 也是如此,它在该字符串前面加上 au 以告诉它它是 unicode。

解决方案:

有一个简单的思路,可以动态解析页面信息。urllib 无法解析动态信息,但浏览器可以。浏览器上显示的处理后的信息实际上是处理后的 HTML 文本。

文件。这为我们抓取动态页面信息提供了一个好思路。Python中有一个著名的图形库——PyQt。虽然 PyQt 是一个图形库,但它有

QtWebkit。这是非常实用的。Google 的 Chrome 和 Apple 的 Safari 都是基于 WebKit 内核开发的,所以我们可以通过 PyQt 获取 QtWebKit

读取页面中的信息并将其加载到 HTML 文档中,然后解析 HTML 文档,从 HTML 文档中提取我们想要使用的信息。

所需材料:

作者自己使用的是 Mac OS X。同样的方法应该也适用于 Windows 和 Linux 平台。

1、Qt4 库

图书馆,而不是造物主。库在Mac的默认安装路径下,应该是/home/username/Developor/,不要更改Qt4的默认安装路径。否则,安装可能会失败。

官方网站:

2、SIP,PyQt4

这两个软件都可以在 PyQt 的官网上找到。下载是它的源代码。Mac 和 Linux 需要自己编译。

下载地址为:

在终端中切换到提取文件的目录。

在终端输入

蟒蛇配置.py

制作

须藤使安装

编译安装。

SIP和PyQt4的安装方法是一样的。但是 PyQt4 依赖于 SIP。所以先安装SIP再安装PyQt4

1、2 两步完成后,Python PyQt4 模块就安装好了。在 Python shell 中键入 import PyQt4 以查看是否可以找到 PyQt4 模块。

3、斯宾纳

spynner 是一个 QtWebKit 客户端,它模拟浏览器来加载页面、引发事件和填写表单。

这个模块可以在 Python 的官方网站上找到。

下载链接:

解压后cd到安装目录,然后输入sudo python configure.py install安装模块。

这样,Spynner 模块就安装好了。在 python shell 中尝试 import spynner 以查看模块是否已安装。

Spynner 的简单使用

Spynner的功能很强大,但是由于我的能力有限,先介绍一下如何展示网页的源代码。

#!/usr/bin/python

#-*-编码:utf-8 -*-

进口斯皮纳

浏览器 = spynner.Browser()

#创建浏览器对象

browser.hide()

#打开浏览器并隐藏它。

browser.load("")

#browser 类中有一个类方法load,可以使用webkit 来加载你要加载的页面信息。

#load(是要加载的 URL 的字符串形式)

打印 browser.html.encode("utf-8")

#browser 类的一个成员是 html,它是页面处理后的源代码字符串。

#转码为UTF-8编码

open("Test.html", 'w+').write(browser.html.encode("utf-8"))

#也可以写入文件,用浏览器打开。

浏览器.close()

#关闭浏览器

通过这个程序,可以比较容易的显示出webkit处理的页面的HTML源代码。

斯宾纳应用程序

下面介绍一下spynner的简单应用。通过一个简单的程序,你就可以得到你在浏览器中看到的页面的所有图片。HTMLParser 文档解析可以用 HTMLParser、BeautifulSoup 等完成,我选择 HTMParser。

#!/usr/bin/python

进口斯皮纳

导入 HTMLParser

导入操作系统

导入 urllib

MyParser 类(HTMLParser.HTMLParser):

def handle_starttag(self, tag, attrs):

如果标签 == 'img':

url = dict(attrs)['src']

name = os.path.basename(dict(attrs)['src'])

如果 name.endswith('.jpg') 或 name.endswith('.png') 或 name.endswith('gif'):

打印“下载.....”,名称

urllib.urlretrieve(网址,名称)

如果 __name__ == "__main__":

浏览器 = spynner.Browser()

浏览器.show()

browser.load("")

解析器 = MyParser()

Parser.feed(browser.html)

打印“完成”

浏览器.close()

通过这个程序,您可以下载您在页面上看到的所有图片。几行简单的程序就可以完成这项艰巨的任务。实现了图像的批处理。这确实是Python语言的优势,然后把繁重的任务交给第三方。

Python如何爬取动态数据实现方法——:你的意思是爬取动态渲染生成的页面,类似于微博的下拉刷新?如果是这样,分析ajax请求找到它,通常是xhr。其实也是考虑使用 selinum 模块(希望我没有拼错模块名)

如何使用Python爬取动态加载的网页数据-:动态网页抓取是一种典型的方法1.直接查看动态网页的加载规则。如果是ajax,找出对python的ajax请求。如果是 js 去处后生成的 URL。有必要阅读JS并了解规则。然后让python生成URL。这是常用的方法2. 方法二,用python调用webkit内核、IE内核、或者有firefox内核的浏览器。然后保存浏览结果。您通常可以使用浏览器测试框架。他们内置了这些功能 3. 方法3,通过http代理,抓取内容并组装起来。您甚至可以嵌入自己的 js 脚本进行挂钩。这种方法常用于系统的逆向工程软件中

python3如何爬取动态加载的网页信息-:方法一在页面中找到xhr请求,获取实际请求参数。直接获取相关搜索的请求返回码,然后进行数据排序。方法二模拟浏览器操作,比如使用 Selenium 模块。

python如何抓取动态页面内容?- :1.首先了解网页爬取的逻辑流程,请参考:【整理】关于爬取网页,分析网页内容,模拟登陆逻辑/流程网站注意事项2.复用工具来分析需要的内容是如何生成的【总结】浏览器中的开发者工具(IE9的F12和Chrome的Ctrl+Shift+I)——网页分析的工具,随便用火狐的firebug也可以用过,不过我用过,感觉不如IE9的F12好用。3. 已经分析,找出是哪个url生成了你需要的数据,然后用python实现相应的代码。

如何使用python抓取网页中隐藏的div内容?:你说的隐藏的div内容应该是动态加载的数据,在网页源码中是不显示的,只有在网页加载的时候才请求显示数据,一般来说,这种数据是存储在一个json文件,只要抓到json文件的url地址解析,然后...

如何使用Python抓取动态页面信息-:很久以前,在学习Python网页编程的时候,涉及到一个Python urllib。您可以使用 urllib.urlopen("url").read() 轻松读取页面信息上的静态信息。但是随着时代的发展,越来越多的网页使用javascript、jQuery、PHP等语言来动态生成页面...

python如何抓取动态加载的网页数据,比如我的工作网络企业链接(需要在底部加载更多才能显示) - : content=urllib.urlopen(url).read() for x in ['LabelWageDes ', 'LabelWorkDes','LabelEnterpriseDesc']: 模式 = pile(r'(.*?)

') for value in pattern.findall(content): answer split_values = value.split('

') 对于 split_values 中的行:打印行

如何使用python爬取js动态生成内容的页面——:python 2.6 + selenium-2.53.6 + firefox45.0 + BeautifulSoup3.@ > 2.1 或 python 2.6 + selenium-2.53.6 + phantomjs 2.1.1

如何使用Python爬取动态页面信息——:Python爬取动态页面和静态页面基本相同。不同的是,一些动态页面对请求头有限制(如cookie\user agent)或ip限制。如果要抓取APP的动态页面没有这些限制,可以使用和静态页面一样的方法,例如: import urllib2 url = "xxxxxx" print urllib2.urlopen( url).read()

Python爬取动态生成的网页需要具备什么知识或用途——:需要有web编程基础,懂一些简单的ajax,需要一个网页抓取调试工具。Mozilla 中有一个萤火虫。如果有人教你,几天。我遇到了一个人,教了她一个星期,但没能把它做好。自己想办法有点困难。可能需要一周左右的时间。 查看全部

抓取网页数据(Python3:用Python3.检测不到正确的编码,解决思路)

您好,首先,sys.setdefaultencoding 是邪恶的。

其次,不使用 Requests 就不要去看文档,不要乱来。

如果 Requests 无法检测到正确的编码,那么你告诉它什么是正确的:

response.encoding = 'gbk'

打印响应.文本

原创内容在response.content、bytes中,你可以随意处理。

绝对不需要为单个请求使用 Session。直接做 requests.get(xxx) 。

最后,如果您不知道如何处理错误编码的字符串,或者使用 Python 3.x,而不是 Shotgun 编程,请考虑一下。

以下是 Python 3。Python 2 也是如此,它在该字符串前面加上 au 以告诉它它是 unicode。

解决方案:

有一个简单的思路,可以动态解析页面信息。urllib 无法解析动态信息,但浏览器可以。浏览器上显示的处理后的信息实际上是处理后的 HTML 文本。

文件。这为我们抓取动态页面信息提供了一个好思路。Python中有一个著名的图形库——PyQt。虽然 PyQt 是一个图形库,但它有

QtWebkit。这是非常实用的。Google 的 Chrome 和 Apple 的 Safari 都是基于 WebKit 内核开发的,所以我们可以通过 PyQt 获取 QtWebKit

读取页面中的信息并将其加载到 HTML 文档中,然后解析 HTML 文档,从 HTML 文档中提取我们想要使用的信息。

所需材料:

作者自己使用的是 Mac OS X。同样的方法应该也适用于 Windows 和 Linux 平台。

1、Qt4 库

图书馆,而不是造物主。库在Mac的默认安装路径下,应该是/home/username/Developor/,不要更改Qt4的默认安装路径。否则,安装可能会失败。

官方网站:

2、SIP,PyQt4

这两个软件都可以在 PyQt 的官网上找到。下载是它的源代码。Mac 和 Linux 需要自己编译。

下载地址为:

在终端中切换到提取文件的目录。

在终端输入

蟒蛇配置.py

制作

须藤使安装

编译安装。

SIP和PyQt4的安装方法是一样的。但是 PyQt4 依赖于 SIP。所以先安装SIP再安装PyQt4

1、2 两步完成后,Python PyQt4 模块就安装好了。在 Python shell 中键入 import PyQt4 以查看是否可以找到 PyQt4 模块。

3、斯宾纳

spynner 是一个 QtWebKit 客户端,它模拟浏览器来加载页面、引发事件和填写表单。

这个模块可以在 Python 的官方网站上找到。

下载链接:

解压后cd到安装目录,然后输入sudo python configure.py install安装模块。

这样,Spynner 模块就安装好了。在 python shell 中尝试 import spynner 以查看模块是否已安装。

Spynner 的简单使用

Spynner的功能很强大,但是由于我的能力有限,先介绍一下如何展示网页的源代码。

#!/usr/bin/python

#-*-编码:utf-8 -*-

进口斯皮纳

浏览器 = spynner.Browser()

#创建浏览器对象

browser.hide()

#打开浏览器并隐藏它。

browser.load("")

#browser 类中有一个类方法load,可以使用webkit 来加载你要加载的页面信息。

#load(是要加载的 URL 的字符串形式)

打印 browser.html.encode("utf-8")

#browser 类的一个成员是 html,它是页面处理后的源代码字符串。

#转码为UTF-8编码

open("Test.html", 'w+').write(browser.html.encode("utf-8"))

#也可以写入文件,用浏览器打开。

浏览器.close()

#关闭浏览器

通过这个程序,可以比较容易的显示出webkit处理的页面的HTML源代码。

斯宾纳应用程序

下面介绍一下spynner的简单应用。通过一个简单的程序,你就可以得到你在浏览器中看到的页面的所有图片。HTMLParser 文档解析可以用 HTMLParser、BeautifulSoup 等完成,我选择 HTMParser。

#!/usr/bin/python

进口斯皮纳

导入 HTMLParser

导入操作系统

导入 urllib

MyParser 类(HTMLParser.HTMLParser):

def handle_starttag(self, tag, attrs):

如果标签 == 'img':

url = dict(attrs)['src']

name = os.path.basename(dict(attrs)['src'])

如果 name.endswith('.jpg') 或 name.endswith('.png') 或 name.endswith('gif'):

打印“下载.....”,名称

urllib.urlretrieve(网址,名称)

如果 __name__ == "__main__":

浏览器 = spynner.Browser()

浏览器.show()

browser.load("")

解析器 = MyParser()

Parser.feed(browser.html)

打印“完成”

浏览器.close()

通过这个程序,您可以下载您在页面上看到的所有图片。几行简单的程序就可以完成这项艰巨的任务。实现了图像的批处理。这确实是Python语言的优势,然后把繁重的任务交给第三方。

Python如何爬取动态数据实现方法——:你的意思是爬取动态渲染生成的页面,类似于微博的下拉刷新?如果是这样,分析ajax请求找到它,通常是xhr。其实也是考虑使用 selinum 模块(希望我没有拼错模块名)

如何使用Python爬取动态加载的网页数据-:动态网页抓取是一种典型的方法1.直接查看动态网页的加载规则。如果是ajax,找出对python的ajax请求。如果是 js 去处后生成的 URL。有必要阅读JS并了解规则。然后让python生成URL。这是常用的方法2. 方法二,用python调用webkit内核、IE内核、或者有firefox内核的浏览器。然后保存浏览结果。您通常可以使用浏览器测试框架。他们内置了这些功能 3. 方法3,通过http代理,抓取内容并组装起来。您甚至可以嵌入自己的 js 脚本进行挂钩。这种方法常用于系统的逆向工程软件中

python3如何爬取动态加载的网页信息-:方法一在页面中找到xhr请求,获取实际请求参数。直接获取相关搜索的请求返回码,然后进行数据排序。方法二模拟浏览器操作,比如使用 Selenium 模块。

python如何抓取动态页面内容?- :1.首先了解网页爬取的逻辑流程,请参考:【整理】关于爬取网页,分析网页内容,模拟登陆逻辑/流程网站注意事项2.复用工具来分析需要的内容是如何生成的【总结】浏览器中的开发者工具(IE9的F12和Chrome的Ctrl+Shift+I)——网页分析的工具,随便用火狐的firebug也可以用过,不过我用过,感觉不如IE9的F12好用。3. 已经分析,找出是哪个url生成了你需要的数据,然后用python实现相应的代码。

如何使用python抓取网页中隐藏的div内容?:你说的隐藏的div内容应该是动态加载的数据,在网页源码中是不显示的,只有在网页加载的时候才请求显示数据,一般来说,这种数据是存储在一个json文件,只要抓到json文件的url地址解析,然后...

如何使用Python抓取动态页面信息-:很久以前,在学习Python网页编程的时候,涉及到一个Python urllib。您可以使用 urllib.urlopen("url").read() 轻松读取页面信息上的静态信息。但是随着时代的发展,越来越多的网页使用javascript、jQuery、PHP等语言来动态生成页面...

python如何抓取动态加载的网页数据,比如我的工作网络企业链接(需要在底部加载更多才能显示) - : content=urllib.urlopen(url).read() for x in ['LabelWageDes ', 'LabelWorkDes','LabelEnterpriseDesc']: 模式 = pile(r'(.*?)

') for value in pattern.findall(content): answer split_values = value.split('

') 对于 split_values 中的行:打印行

如何使用python爬取js动态生成内容的页面——:python 2.6 + selenium-2.53.6 + firefox45.0 + BeautifulSoup3.@ > 2.1 或 python 2.6 + selenium-2.53.6 + phantomjs 2.1.1

如何使用Python爬取动态页面信息——:Python爬取动态页面和静态页面基本相同。不同的是,一些动态页面对请求头有限制(如cookie\user agent)或ip限制。如果要抓取APP的动态页面没有这些限制,可以使用和静态页面一样的方法,例如: import urllib2 url = "xxxxxx" print urllib2.urlopen( url).read()

Python爬取动态生成的网页需要具备什么知识或用途——:需要有web编程基础,懂一些简单的ajax,需要一个网页抓取调试工具。Mozilla 中有一个萤火虫。如果有人教你,几天。我遇到了一个人,教了她一个星期,但没能把它做好。自己想办法有点困难。可能需要一周左右的时间。

抓取网页数据(如何从网站爬网数据中获取结构化数据?() )

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2022-04-09 19:24

)

原创来源:Works (3 Best Ways to Scrape Data from 网站) / 网站 Name (Octoparse)

原创链接:从网站抓取数据的最佳 3 种方法

在过去的几年里,抓取数据的需求变得越来越大。爬取的数据可用于不同领域的评估或预测。在这里,我想谈谈我们可以采取的三种方法来从 网站 爬取数据。

1.使用网站API

许多大型社交媒体 网站,例如 Facebook、Twitter、Instagram、StackOverflow,都提供 API 供用户访问他们的数据。有时,您可以选择官方 API 来获取结构化数据。如下面的 Facebook Graph API 所示,您需要选择要查询的字段,然后对数据进行排序、执行 URL 查找、发出请求等。要了解更多信息,请参阅 /docs/graph-api/using-graph-api。

2.构建自己的爬虫

但是,并非所有 网站 都向用户提供 API。部分网站由于技术限制或其他原因拒绝提供任何公共API。有人可能会提出 RSS 提要,但由于使用受限,我不会建议或评论它们。在这种情况下,我想讨论的是,我们可以构建自己的爬虫来处理这种情况。

爬虫如何工作?换句话说,爬虫是一种生成可以由提取器提供的 URL 列表的方法。爬虫可以定义为查找 URL 的工具。首先,您为爬虫提供一个要启动的网页,它们会跟随该页面上的所有链接。然后该过程将继续循环。

然后,我们可以继续构建自己的爬虫。众所周知,Python 是一种开源编程语言,您可以找到许多有用的函数库。这里我推荐 BeautifulSoup(一个 Python 库),因为它易于使用并且具有许多直观的字符。更准确地说,我将使用两个 Python 模块来抓取数据。

BeautifulSoup 无法为我们获取网页。这就是我将 urllib2 与 BeautifulSoup 库一起使用的原因。然后我们需要处理 HTML 标记以找到页面标记和右表中的所有链接。之后,遍历每一行 (tr) 并将 tr (td) 的每个元素分配给一个变量并将其附加到列表中。首先我们看一下表格的HTML结构(我不会提取表格头信息)。

通过采用这种方法,您的爬虫是定制的。它可以处理API提取中遇到的一些困难。您可以使用代理来防止它被某些 网站 等阻止。整个过程在您的控制范围内。这种方法对于具有编码技能的人应该是有意义的。您抓取的数据框应如下图所示。

3.使用现成的爬虫工具

但是,以编程方式自行抓取 网站 网络可能会很耗时。对于没有任何编码技能的人来说,这将是一项艰巨的任务。因此,我想介绍一些爬虫工具。

八度分析

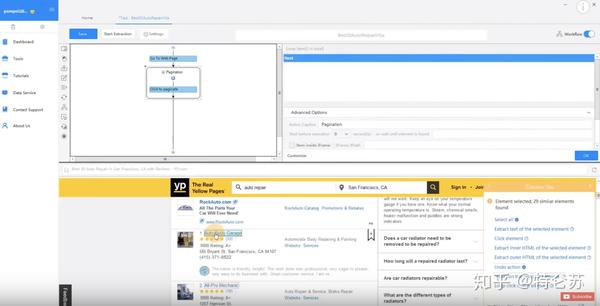

Octoparse 是一个强大的基于 Visual Windows 的网络数据爬虫。用户可以使用其简单友好的用户界面轻松掌握此工具。要使用它,您需要在本地桌面上下载此应用程序。

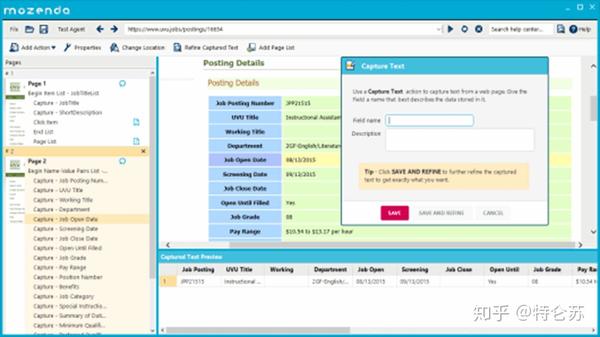

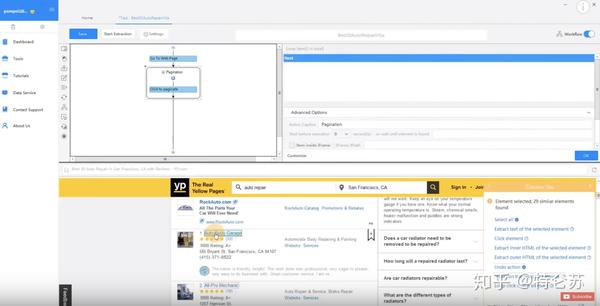

如下图所示,您可以在 Workflow Designer 窗格中单击并拖动这些块来自定义您自己的任务。Octoparse 提供两种版本的爬虫服务订阅计划——免费和付费。两者都可以满足用户基本的刮或刮需求。使用免费版本,您可以在本地运行任务。

如果您将免费版切换到付费版,您可以通过将任务上传到云平台来使用基于云的服务。6 到 14 台云服务器将同时以更高的速度运行您的任务,并在更广泛的范围内爬行。此外,您可以使用 Octoparse 的匿名代理功能自动提取数据而不留下任何痕迹,该功能可以轮流使用大量 IP,从而可以防止您被某些 网站 阻止。这是一个介绍 Octoparse 云提取的视频。

Octoparse 还提供 API 以将您的系统实时连接到您抓取的数据。您可以将 Octoparse 数据导入您自己的数据库或使用 API 请求访问您帐户的数据。完成任务配置后,您可以将数据导出为CSV、Excel、HTML、TXT和数据库(MySQL、SQL Server和Oracle)等多种格式。

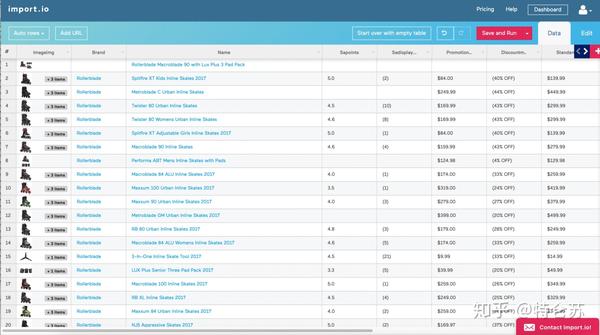

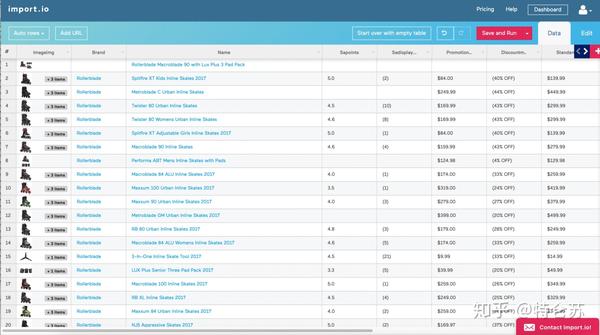

进口

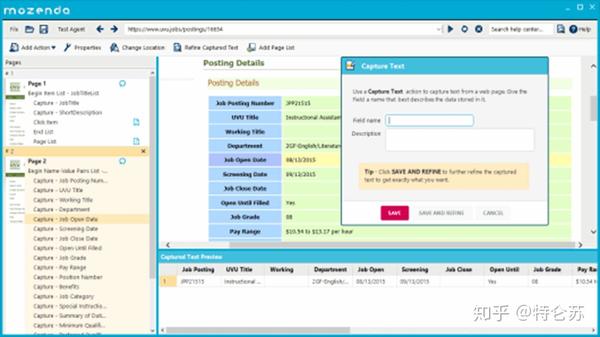

Import.io,也称为网络爬虫,涵盖了所有不同级别的爬虫需求。它提供了一个神奇的工具,无需任何培训即可将站点转换为表格。对于更复杂的 网站 爬取,建议用户下载他们的桌面应用程序。构建 API 后,它们会提供许多简单的集成选项,例如 Google Sheets、Plot.ly、Excel 以及 GET 和 POST 请求。当您考虑到所有这些都伴随着终生免费的价格标签和强大的支持团队时,import.io 无疑是那些寻找结构化数据的人的首选。他们还为寻求更大规模或更复杂数据提取的公司提供企业级付费选项。

本山达

Mozenda 是另一个用户友好的网络数据提取器。它为用户提供点击式 UI,无需任何编码技能即可使用。Mozenda 还消除了自动化和发布提取数据的麻烦。一次告诉 Mozenda 您想要什么数据,然后根据需要多次获取。此外,它允许使用 REST API 进行高级编程,用户可以直接连接 Mozenda 帐户。它还提供基于云的服务以及 IP 轮换。

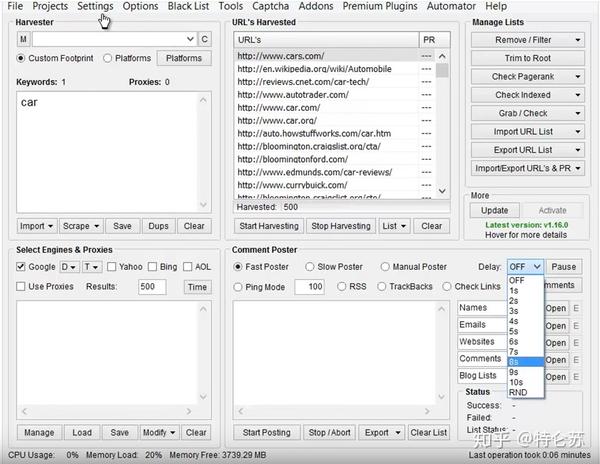

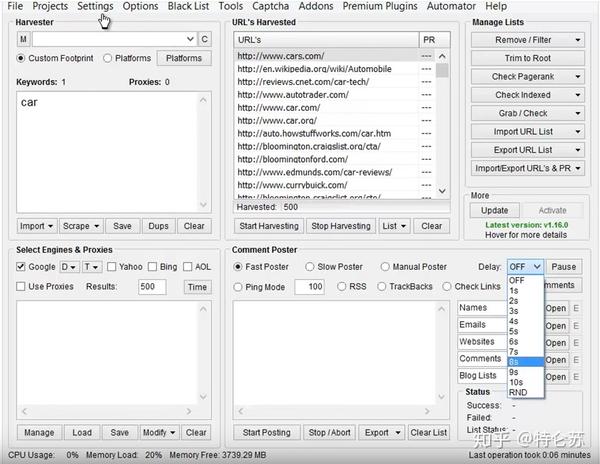

刮框

搜索引擎优化专家、在线营销人员甚至垃圾邮件发送者应该对 ScrapeBox 非常熟悉,它具有非常人性化的界面。用户可以轻松地从 网站 采集数据以获取电子邮件、检查页面排名、验证工作代理和 RSS 提交。通过使用数以千计的轮换代理,您将能够隐藏竞争对手的 网站 关键字、对 .gov网站 进行研究、采集数据并发表评论,而不会被阻止或检测到。

谷歌网络爬虫插件

如果人们只是想以一种简单的方式抓取数据,我建议您选择 Google Web Scraper 插件。它是一个基于浏览器的网络爬虫,其工作方式类似于 Firefox 的 Outwit Hub。您可以将其作为扩展程序下载并安装在浏览器中。您需要突出显示要抓取的数据字段,右键单击并选择“Scrape like...”。与您突出显示的内容类似的任何内容都将呈现在一个准备导出的表格中,并且与 Google Docs 兼容。最新版本的电子表格仍有一些错误。虽然它操作简单,但它应该是所有用户都应该注意的,但它不能大量抓取图像和抓取数据。

查看全部

抓取网页数据(如何从网站爬网数据中获取结构化数据?()

)

原创来源:Works (3 Best Ways to Scrape Data from 网站) / 网站 Name (Octoparse)

原创链接:从网站抓取数据的最佳 3 种方法

在过去的几年里,抓取数据的需求变得越来越大。爬取的数据可用于不同领域的评估或预测。在这里,我想谈谈我们可以采取的三种方法来从 网站 爬取数据。

1.使用网站API

许多大型社交媒体 网站,例如 Facebook、Twitter、Instagram、StackOverflow,都提供 API 供用户访问他们的数据。有时,您可以选择官方 API 来获取结构化数据。如下面的 Facebook Graph API 所示,您需要选择要查询的字段,然后对数据进行排序、执行 URL 查找、发出请求等。要了解更多信息,请参阅 /docs/graph-api/using-graph-api。

2.构建自己的爬虫

但是,并非所有 网站 都向用户提供 API。部分网站由于技术限制或其他原因拒绝提供任何公共API。有人可能会提出 RSS 提要,但由于使用受限,我不会建议或评论它们。在这种情况下,我想讨论的是,我们可以构建自己的爬虫来处理这种情况。

爬虫如何工作?换句话说,爬虫是一种生成可以由提取器提供的 URL 列表的方法。爬虫可以定义为查找 URL 的工具。首先,您为爬虫提供一个要启动的网页,它们会跟随该页面上的所有链接。然后该过程将继续循环。

然后,我们可以继续构建自己的爬虫。众所周知,Python 是一种开源编程语言,您可以找到许多有用的函数库。这里我推荐 BeautifulSoup(一个 Python 库),因为它易于使用并且具有许多直观的字符。更准确地说,我将使用两个 Python 模块来抓取数据。

BeautifulSoup 无法为我们获取网页。这就是我将 urllib2 与 BeautifulSoup 库一起使用的原因。然后我们需要处理 HTML 标记以找到页面标记和右表中的所有链接。之后,遍历每一行 (tr) 并将 tr (td) 的每个元素分配给一个变量并将其附加到列表中。首先我们看一下表格的HTML结构(我不会提取表格头信息)。

通过采用这种方法,您的爬虫是定制的。它可以处理API提取中遇到的一些困难。您可以使用代理来防止它被某些 网站 等阻止。整个过程在您的控制范围内。这种方法对于具有编码技能的人应该是有意义的。您抓取的数据框应如下图所示。

3.使用现成的爬虫工具

但是,以编程方式自行抓取 网站 网络可能会很耗时。对于没有任何编码技能的人来说,这将是一项艰巨的任务。因此,我想介绍一些爬虫工具。

八度分析

Octoparse 是一个强大的基于 Visual Windows 的网络数据爬虫。用户可以使用其简单友好的用户界面轻松掌握此工具。要使用它,您需要在本地桌面上下载此应用程序。

如下图所示,您可以在 Workflow Designer 窗格中单击并拖动这些块来自定义您自己的任务。Octoparse 提供两种版本的爬虫服务订阅计划——免费和付费。两者都可以满足用户基本的刮或刮需求。使用免费版本,您可以在本地运行任务。

如果您将免费版切换到付费版,您可以通过将任务上传到云平台来使用基于云的服务。6 到 14 台云服务器将同时以更高的速度运行您的任务,并在更广泛的范围内爬行。此外,您可以使用 Octoparse 的匿名代理功能自动提取数据而不留下任何痕迹,该功能可以轮流使用大量 IP,从而可以防止您被某些 网站 阻止。这是一个介绍 Octoparse 云提取的视频。

Octoparse 还提供 API 以将您的系统实时连接到您抓取的数据。您可以将 Octoparse 数据导入您自己的数据库或使用 API 请求访问您帐户的数据。完成任务配置后,您可以将数据导出为CSV、Excel、HTML、TXT和数据库(MySQL、SQL Server和Oracle)等多种格式。

进口

Import.io,也称为网络爬虫,涵盖了所有不同级别的爬虫需求。它提供了一个神奇的工具,无需任何培训即可将站点转换为表格。对于更复杂的 网站 爬取,建议用户下载他们的桌面应用程序。构建 API 后,它们会提供许多简单的集成选项,例如 Google Sheets、Plot.ly、Excel 以及 GET 和 POST 请求。当您考虑到所有这些都伴随着终生免费的价格标签和强大的支持团队时,import.io 无疑是那些寻找结构化数据的人的首选。他们还为寻求更大规模或更复杂数据提取的公司提供企业级付费选项。

本山达

Mozenda 是另一个用户友好的网络数据提取器。它为用户提供点击式 UI,无需任何编码技能即可使用。Mozenda 还消除了自动化和发布提取数据的麻烦。一次告诉 Mozenda 您想要什么数据,然后根据需要多次获取。此外,它允许使用 REST API 进行高级编程,用户可以直接连接 Mozenda 帐户。它还提供基于云的服务以及 IP 轮换。

刮框

搜索引擎优化专家、在线营销人员甚至垃圾邮件发送者应该对 ScrapeBox 非常熟悉,它具有非常人性化的界面。用户可以轻松地从 网站 采集数据以获取电子邮件、检查页面排名、验证工作代理和 RSS 提交。通过使用数以千计的轮换代理,您将能够隐藏竞争对手的 网站 关键字、对 .gov网站 进行研究、采集数据并发表评论,而不会被阻止或检测到。

谷歌网络爬虫插件

如果人们只是想以一种简单的方式抓取数据,我建议您选择 Google Web Scraper 插件。它是一个基于浏览器的网络爬虫,其工作方式类似于 Firefox 的 Outwit Hub。您可以将其作为扩展程序下载并安装在浏览器中。您需要突出显示要抓取的数据字段,右键单击并选择“Scrape like...”。与您突出显示的内容类似的任何内容都将呈现在一个准备导出的表格中,并且与 Google Docs 兼容。最新版本的电子表格仍有一些错误。虽然它操作简单,但它应该是所有用户都应该注意的,但它不能大量抓取图像和抓取数据。

抓取网页数据(string定义函数getHTMLText()获取网页信息定义printUnivList )

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-04-02 04:07

)

Python爬虫--2019大学排名数据爬取准备输入:大学排名URL连接输出:大学排名信息屏幕输出所需库:requests,bs4获取网页信息的思路提取网页中的内容,放入数据结构,数据结构用于显示和输出结果。编程定义函数getHTMLText()获取网页信息。定义函数UnivList()放入数据结构定义函数printUnivList()中,输出到屏幕上。

总体:

查看url源码的步骤

分析源码看看要爬取的内容在哪里

从图中可以看出,排名信息在标签中

具体信息为标签下标签中的字符串

定义函数getHTMLText

def getHMLText(url):

'''

获取url信息,输出url的内容,来抓取网页的信息

'''

try:

r = request.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "抓取失败!"

定义函数UnivList()

def UnivList(ulist, html):

'''

提取html中的数据,放入到ulist列表,完成数据提取

'''

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find('tbody').children:

if isinstance(tr, bs4.element.Tag): # 判断tr的子节点是否为非属性字符串

tds = tr('td')

# print(tds)

# print('#' * 30)

# print(tds[0], tds[0].string)

# print('#' * 30)

# print(tds[1], tds[1].string)

# print('#' * 30)

# print(tds[2], tds[2].string)

# print('#' * 30)

# print(tds[3], tds[3].string)

ulist.append([tds[0].string, tds[1].string, tds[3].string, tds[2].string])

定义函数 printUnivList()

def printUnivList(ulist, num):

'''

将ulist列表信息打印,num表示打印前多少排名的学校

'''

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format("排名", "学校名称", "总分", '地址'))

for i in range(num):

u = ulist[i]

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format(u[0], u[1], u[2], u[3]))

主函数 main()

def main():

'''

实现整个代码

'''

ulist = []

url = 'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html'

html = getHTMLText(url)

UnivList(ulist, html)

printUnivList(ulist, 100)

调用主函数

main()

完整代码

import requests

import bs4

from bs4 import BeautifulSoup

def getHMLText(url):

'''

获取url信息,输出url的内容,来抓取网页的信息

'''

try:

r = request.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "抓取失败!"

def UnivList(ulist, html):

'''

提取html中的数据,放入到ulist列表,完成数据提取

'''

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find('tbody').children:

if isinstance(tr, bs4.element.Tag): # 判断tr的子节点是否为非属性字符串

tds = tr('td')

# print(tds)

# print('#' * 30)

# print(tds[0], tds[0].string)

# print('#' * 30)

# print(tds[1], tds[1].string)

# print('#' * 30)

# print(tds[2], tds[2].string)

# print('#' * 30)

# print(tds[3], tds[3].string)

ulist.append([tds[0].string, tds[1].string, tds[3].string, tds[2].string])

def printUnivList(ulist, num):

'''

将ulist列表信息打印,num表示打印前多少排名的学校

'''

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format("排名", "学校名称", "总分", '地址'))

for i in range(num):

u = ulist[i]

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format(u[0], u[1], u[2], u[3]))

def main():

'''

实现整个代码

'''

uinfo = []

url = 'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html'

html = getHTMLText(url)

fillUnivList(uinfo, html)

printUnivList(uinfo, 100)

main() 查看全部

抓取网页数据(string定义函数getHTMLText()获取网页信息定义printUnivList

)

Python爬虫--2019大学排名数据爬取准备输入:大学排名URL连接输出:大学排名信息屏幕输出所需库:requests,bs4获取网页信息的思路提取网页中的内容,放入数据结构,数据结构用于显示和输出结果。编程定义函数getHTMLText()获取网页信息。定义函数UnivList()放入数据结构定义函数printUnivList()中,输出到屏幕上。

总体:

查看url源码的步骤

分析源码看看要爬取的内容在哪里

从图中可以看出,排名信息在标签中

具体信息为标签下标签中的字符串

定义函数getHTMLText

def getHMLText(url):

'''

获取url信息,输出url的内容,来抓取网页的信息

'''

try:

r = request.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "抓取失败!"

定义函数UnivList()

def UnivList(ulist, html):

'''

提取html中的数据,放入到ulist列表,完成数据提取

'''

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find('tbody').children:

if isinstance(tr, bs4.element.Tag): # 判断tr的子节点是否为非属性字符串

tds = tr('td')

# print(tds)

# print('#' * 30)

# print(tds[0], tds[0].string)

# print('#' * 30)

# print(tds[1], tds[1].string)

# print('#' * 30)

# print(tds[2], tds[2].string)

# print('#' * 30)

# print(tds[3], tds[3].string)

ulist.append([tds[0].string, tds[1].string, tds[3].string, tds[2].string])

定义函数 printUnivList()

def printUnivList(ulist, num):

'''

将ulist列表信息打印,num表示打印前多少排名的学校

'''

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format("排名", "学校名称", "总分", '地址'))

for i in range(num):

u = ulist[i]

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format(u[0], u[1], u[2], u[3]))

主函数 main()

def main():

'''

实现整个代码

'''

ulist = []

url = 'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html'

html = getHTMLText(url)

UnivList(ulist, html)

printUnivList(ulist, 100)

调用主函数

main()

完整代码

import requests

import bs4

from bs4 import BeautifulSoup

def getHMLText(url):

'''

获取url信息,输出url的内容,来抓取网页的信息

'''

try:

r = request.get(url, timeout=30)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

return "抓取失败!"

def UnivList(ulist, html):

'''

提取html中的数据,放入到ulist列表,完成数据提取

'''

soup = BeautifulSoup(html, "html.parser")

for tr in soup.find('tbody').children:

if isinstance(tr, bs4.element.Tag): # 判断tr的子节点是否为非属性字符串

tds = tr('td')

# print(tds)

# print('#' * 30)

# print(tds[0], tds[0].string)

# print('#' * 30)

# print(tds[1], tds[1].string)

# print('#' * 30)

# print(tds[2], tds[2].string)

# print('#' * 30)

# print(tds[3], tds[3].string)

ulist.append([tds[0].string, tds[1].string, tds[3].string, tds[2].string])

def printUnivList(ulist, num):

'''

将ulist列表信息打印,num表示打印前多少排名的学校

'''

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format("排名", "学校名称", "总分", '地址'))

for i in range(num):

u = ulist[i]

print("{:^3}\t{:^10}\t{:^20}\t{:^30}".format(u[0], u[1], u[2], u[3]))

def main():

'''

实现整个代码

'''

uinfo = []

url = 'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2019.html'

html = getHTMLText(url)

fillUnivList(uinfo, html)

printUnivList(uinfo, 100)

main()

抓取网页数据(用Python编写的Web爬虫和抓取器的区别)

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2022-04-01 15:07

网站Crawling 是一个用 Python 编写的网络爬虫和网络抓取框架。【小淘气数据库】网站Crawling 是一个完整的框架,所以它收录了网页抓取所需的一切,包括一个用于发送HTTP 请求和从下载的HTML 页面解析数据的抓取模块。它可以渲染 JavaScript,网站从网页中抓取和解析数据变得容易。它位于 HTML 或 XML 解析器之上,为网站管理员提供了一种 Python 方式来访问数据。所以网站爬取是站长需要了解的采集文章填充网站内容的工具。

网页抓取是一种从网页中获取页面内容的技术。通常通过 网站 抓取,使用低级超文本传输协议来模拟正常的人类访问。网络爬虫与网络索引非常相似,其中网络索引是指大多数搜索引擎使用的机器人或网络爬虫等技术。相比之下,网络抓取更侧重于将网络上的非结构化数据(通常为 HTML 格式)转换为可以在中央数据库和电子表格中存储和分析的结构化数据。网络抓取还涉及网络自动化,它使用计算机软件来模拟人类浏览。

网页抓取文本搜索和正则表达式:文本搜索和正则表达式可以有效地从页面中提取所需的内容。网页抓取可以在基于UNIX的系统上使用grep,在其他平台或其他编程语言(如Perl、Python)中都有对应的命令或语法。网页抓取是基于HTTP编程的:无论是静态网页还是动态网页,都可以通过向服务器发送HTTP请求来获取,所以可以通过直接socket编程来实现。

网站爬取的HTML解析器:很多网站使用数据库来存储自己的数据,当用户访问时,由程序按照指定的格式自动生成。因此,可以使用语法分析器对网站爬取得到的HTML页面进行解析,然后使用HTML标签提取出需要的内容。与使用HTML解析器的文本搜索和正则表达式【小淘气数据库】相比,该程序更加健壮,并且无需构建复杂的正则表达式。

网站爬虫应用,从搜索引擎优化(SEO)分析到搜索引擎索引、一般性能监控等,它的一些应用可能还包括爬取网页。网站抓取只需要提交网站首页URL,其他页面(如列表页、内容页)会自动抓取。网站抓取的模板收录HTML、CSS、图片、JS、Flash等目录并保存在原站点结构中,替换对应的cms标签即可使用。

网站 掌握最新海量网络信息采集、处理、存储、全文检索、中文处理和文本挖掘技术,可实时监控最新新闻、论坛、博客、微博和视频。舆情信息帮助站长及时、全面、准确地掌握网络动态,自动采集到自己网站,用户填写网站的内容。

网站爬虫使用自然语言处理技术,保证抓取信息的准确性、分类的准确性和否定判断的准确性。网站抓取相似文章识别,准确识别出内容相似的文章,可用于文章的去重和识别。网站爬取无需模板,方便随时添加采集源,不受网页修改影响。网站捕捉全方位的数据分析展示功能,多角度多层次展示内容特征,揭示数据规律,帮助站长更好的管理和维护网站。 查看全部

抓取网页数据(用Python编写的Web爬虫和抓取器的区别)

网站Crawling 是一个用 Python 编写的网络爬虫和网络抓取框架。【小淘气数据库】网站Crawling 是一个完整的框架,所以它收录了网页抓取所需的一切,包括一个用于发送HTTP 请求和从下载的HTML 页面解析数据的抓取模块。它可以渲染 JavaScript,网站从网页中抓取和解析数据变得容易。它位于 HTML 或 XML 解析器之上,为网站管理员提供了一种 Python 方式来访问数据。所以网站爬取是站长需要了解的采集文章填充网站内容的工具。

网页抓取是一种从网页中获取页面内容的技术。通常通过 网站 抓取,使用低级超文本传输协议来模拟正常的人类访问。网络爬虫与网络索引非常相似,其中网络索引是指大多数搜索引擎使用的机器人或网络爬虫等技术。相比之下,网络抓取更侧重于将网络上的非结构化数据(通常为 HTML 格式)转换为可以在中央数据库和电子表格中存储和分析的结构化数据。网络抓取还涉及网络自动化,它使用计算机软件来模拟人类浏览。

网页抓取文本搜索和正则表达式:文本搜索和正则表达式可以有效地从页面中提取所需的内容。网页抓取可以在基于UNIX的系统上使用grep,在其他平台或其他编程语言(如Perl、Python)中都有对应的命令或语法。网页抓取是基于HTTP编程的:无论是静态网页还是动态网页,都可以通过向服务器发送HTTP请求来获取,所以可以通过直接socket编程来实现。

网站爬取的HTML解析器:很多网站使用数据库来存储自己的数据,当用户访问时,由程序按照指定的格式自动生成。因此,可以使用语法分析器对网站爬取得到的HTML页面进行解析,然后使用HTML标签提取出需要的内容。与使用HTML解析器的文本搜索和正则表达式【小淘气数据库】相比,该程序更加健壮,并且无需构建复杂的正则表达式。

网站爬虫应用,从搜索引擎优化(SEO)分析到搜索引擎索引、一般性能监控等,它的一些应用可能还包括爬取网页。网站抓取只需要提交网站首页URL,其他页面(如列表页、内容页)会自动抓取。网站抓取的模板收录HTML、CSS、图片、JS、Flash等目录并保存在原站点结构中,替换对应的cms标签即可使用。

网站 掌握最新海量网络信息采集、处理、存储、全文检索、中文处理和文本挖掘技术,可实时监控最新新闻、论坛、博客、微博和视频。舆情信息帮助站长及时、全面、准确地掌握网络动态,自动采集到自己网站,用户填写网站的内容。

网站爬虫使用自然语言处理技术,保证抓取信息的准确性、分类的准确性和否定判断的准确性。网站抓取相似文章识别,准确识别出内容相似的文章,可用于文章的去重和识别。网站爬取无需模板,方便随时添加采集源,不受网页修改影响。网站捕捉全方位的数据分析展示功能,多角度多层次展示内容特征,揭示数据规律,帮助站长更好的管理和维护网站。

抓取网页数据(爬虫分析网页2.对网页发送请求,获取响应3.提取解析 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-03-31 02:16

)

相信很多朋友还是喜欢买基金的,今天正好有时间给大家送个基金。虽然不可能致富,但对理财还是有帮助的。代码放在下面。

爬虫大体思路:

1.分析网页

2.向网页发送请求并获得响应

3.提取解析数据

4.保存数据

Python版本:3.6.5

import requests

import time

import csv

import re

分析网页

其实这个网站的网页数据并没有太多的反爬,就是网页需要构造一个params的参数,里面收录翻页的数据和时间戳数据。这些是动态的,你需要如何自己做呢?指定它,如图所示:

经过上面的分析,你可以向链接发送请求,但是这个网站和其他地方不同。他返回给你的不是html源码,也不是json数据,而是字符数据。如图所示:

我们可以看到这些不同的html和json数据,所以我们需要使用正则表达式来过滤和提取。经过上面的分析,我的大致思路是先爬取一页数据,使用正则抽取成功爬取一页数据,然后再做一个循环爬取多页数据。

代码部分:

构建请求所需的参数

###

###Python学习交流Q群:906715085####

def get_params(self):

"""

构建params参数的方法

:return:

"""

params = {

"t": "1",

"lx": "1",

"letter": "",

"gsid": "",

"text": "",

"sort": "zdf,desc",

"page": f"{str(self.page)},200",

"dt": str(self.TIMESTRF),

"atfc": "",

"onlySale": "0",

}

return params

上面提到的dt参数是一个不规则的时间戳,那我们该怎么办呢?思路是用time模块先提取出真正的当前时间戳,然后用int()强制成整数,再乘以1000,就可以得到这个不规则的时间戳。构造的时候可以把这个时间戳转换成str()。

int(time.time()) * 1000

发送请求,获取响应数据

def parse_url(self, url):

"""

发送请求,获取响应数据的方法

:param url:

:return:

"""

params = self.get_params()

response = requests.get(url, headers=self.headers, params=params)

if response.status_code == 200:

return response.content.decode()

提取数据

def get_data(self, data_str):

"""

提取基金数据的方法

:param data_str:

:return:

"""

str_data = re.findall('var db=.*,datas:(.*),count:.*}', data_str, re.S)[0]

data_list = eval(str_data)

for data in data_list:

yield {

'基金代码': data[0],

'基金简称': data[1],

'单位净值': data[3],

'累计净值': data[4],

'日增长值': data[6],

'日增长率': data[7],

'手续费': data[17]

}

实现方案的完整思路

def run(self):

"""

实现主要逻辑思路

:return:

"""

with open('./jjData.csv', 'a', encoding='utf-8-sig', newline="") as csvfile:

fieldnames = ['基金代码', '基金简称', '单位净值', '累计净值', '日增长值', '日增长率', '手续费']

write_dict = csv.DictWriter(csvfile, fieldnames=fieldnames)

write_dict.writeheader()

# 1,发送请求,获取响应数据

data_str = self.parse_url(self.API_URL)

# 2,提取数据

fund_data_list = self.get_data(data_str)

for fund_data in fund_data_list:

print(fund_data)

# 3,保存数据

write_dict.writerow(fund_data)

显示结果

结尾

最后,这里没有更多了。不明白的可以关注视频再学习。本文文章到此结束。喜欢的可以点赞,不明白的可以评论留言。

查看全部

抓取网页数据(爬虫分析网页2.对网页发送请求,获取响应3.提取解析

)

相信很多朋友还是喜欢买基金的,今天正好有时间给大家送个基金。虽然不可能致富,但对理财还是有帮助的。代码放在下面。

爬虫大体思路:

1.分析网页

2.向网页发送请求并获得响应

3.提取解析数据

4.保存数据

Python版本:3.6.5

import requests

import time

import csv

import re

分析网页

其实这个网站的网页数据并没有太多的反爬,就是网页需要构造一个params的参数,里面收录翻页的数据和时间戳数据。这些是动态的,你需要如何自己做呢?指定它,如图所示:

经过上面的分析,你可以向链接发送请求,但是这个网站和其他地方不同。他返回给你的不是html源码,也不是json数据,而是字符数据。如图所示:

我们可以看到这些不同的html和json数据,所以我们需要使用正则表达式来过滤和提取。经过上面的分析,我的大致思路是先爬取一页数据,使用正则抽取成功爬取一页数据,然后再做一个循环爬取多页数据。

代码部分:

构建请求所需的参数

###

###Python学习交流Q群:906715085####

def get_params(self):

"""

构建params参数的方法

:return:

"""

params = {

"t": "1",

"lx": "1",

"letter": "",

"gsid": "",

"text": "",

"sort": "zdf,desc",

"page": f"{str(self.page)},200",

"dt": str(self.TIMESTRF),

"atfc": "",

"onlySale": "0",

}

return params

上面提到的dt参数是一个不规则的时间戳,那我们该怎么办呢?思路是用time模块先提取出真正的当前时间戳,然后用int()强制成整数,再乘以1000,就可以得到这个不规则的时间戳。构造的时候可以把这个时间戳转换成str()。

int(time.time()) * 1000

发送请求,获取响应数据

def parse_url(self, url):

"""

发送请求,获取响应数据的方法

:param url:

:return:

"""

params = self.get_params()

response = requests.get(url, headers=self.headers, params=params)

if response.status_code == 200:

return response.content.decode()

提取数据

def get_data(self, data_str):

"""

提取基金数据的方法

:param data_str:

:return:

"""

str_data = re.findall('var db=.*,datas:(.*),count:.*}', data_str, re.S)[0]

data_list = eval(str_data)

for data in data_list:

yield {

'基金代码': data[0],

'基金简称': data[1],

'单位净值': data[3],

'累计净值': data[4],

'日增长值': data[6],

'日增长率': data[7],

'手续费': data[17]

}

实现方案的完整思路

def run(self):

"""

实现主要逻辑思路

:return:

"""

with open('./jjData.csv', 'a', encoding='utf-8-sig', newline="") as csvfile:

fieldnames = ['基金代码', '基金简称', '单位净值', '累计净值', '日增长值', '日增长率', '手续费']

write_dict = csv.DictWriter(csvfile, fieldnames=fieldnames)

write_dict.writeheader()

# 1,发送请求,获取响应数据

data_str = self.parse_url(self.API_URL)

# 2,提取数据

fund_data_list = self.get_data(data_str)

for fund_data in fund_data_list:

print(fund_data)

# 3,保存数据

write_dict.writerow(fund_data)

显示结果

结尾

最后,这里没有更多了。不明白的可以关注视频再学习。本文文章到此结束。喜欢的可以点赞,不明白的可以评论留言。

抓取网页数据(2016年10月12日影刀强烈推荐这款)

网站优化 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2022-03-28 05:11

目前国内外比较流行的RPA产品在国内有影刀、Uibot、鸿基、阿里云RPA,国外有UiPath和Blue Prism。我主要展示国货。原因很简单。国货更符合国货业务,更适合大家的操作习惯。重点介绍以下两款产品:

一、影刀

强烈推荐该产品,原因如下:

1、拖放操作,方便快捷

2、以人为的思维顺序执行任务的命令式过程

3、0码,没有编程经验的朋友可以玩得开心

4、支持python开发,可以很好的与其他办公自动化功能集成

二、Uibot

它也是一款出色的产品,具有以下特点:

1、通过流程图的方式构建流程

2、支持C、C#等其他语言

本产品比较适合一些开发伙伴。比如我是做C#开发的,以后会有Uibot的实际操作。

总之,目前市场上的RPA产品已经非常成熟和强大。小伙伴可以根据自己的情况选择适合自己的产品。这些产品只是我们的工具,更重要的是业务发展的思维。

那么我们进入正题,数据爬取不再是一个陌生的概念,无论是程序还是一些工具都可以帮助我们获取公共数据。当然,RPA可以做到,也可以做得更方便。让我们来看看。

注意:在执行任务之前,一定要准备好工具、目标和流程

使用工具:暗影刀 RPA

目标:抓取老板直聘中RPA的工作清单数据网站

流程图:

第一步:打开网页

第 2 步:输入关键字

填写输入框(web):我们需要告诉工具输入框在哪里,所以我们需要捕获输入框

第三部分:点击搜索

点击元素(web):我们需要告诉工具搜索按钮在哪里,所以我们需要捕获搜索按钮

第 4 步:显示结果

注意:这里使用等待两秒等待数据显示,这是保证流程顺利执行的保证条件之一。未来会有更深入的解释,使用各种方法来提高过程的鲁棒性。

第 5 步:数据捕获

这里我们需要抓取相似的元素来确定数据规则,比如职位:RPA开发工程师,它位于网页列表中的固定位置,我们只需要抓取两个不同的职位,告诉工具我们想要获取有关此元素的信息。

注意:必须是类似的元素,比如上图中的“RPA开发工程师”和“RPA开发负责人”,这样我们才能抓取页面上的所有职位信息,如下图:

当然,我们也可以抓取其他元素,只要添加一个新列,然后抓取两次元素,记住,一定是两个不同但相似的元素。

这样,我们通过5个步骤抓取了网页的数据。我这里写的比较详细,其实不到一分钟就写完了。

以上就是网站数据采集软件(如何采集网页数据)的相关内容,更多精彩我们 查看全部

抓取网页数据(2016年10月12日影刀强烈推荐这款)

目前国内外比较流行的RPA产品在国内有影刀、Uibot、鸿基、阿里云RPA,国外有UiPath和Blue Prism。我主要展示国货。原因很简单。国货更符合国货业务,更适合大家的操作习惯。重点介绍以下两款产品:

一、影刀

强烈推荐该产品,原因如下:

1、拖放操作,方便快捷

2、以人为的思维顺序执行任务的命令式过程

3、0码,没有编程经验的朋友可以玩得开心

4、支持python开发,可以很好的与其他办公自动化功能集成

二、Uibot

它也是一款出色的产品,具有以下特点:

1、通过流程图的方式构建流程

2、支持C、C#等其他语言

本产品比较适合一些开发伙伴。比如我是做C#开发的,以后会有Uibot的实际操作。

总之,目前市场上的RPA产品已经非常成熟和强大。小伙伴可以根据自己的情况选择适合自己的产品。这些产品只是我们的工具,更重要的是业务发展的思维。

那么我们进入正题,数据爬取不再是一个陌生的概念,无论是程序还是一些工具都可以帮助我们获取公共数据。当然,RPA可以做到,也可以做得更方便。让我们来看看。

注意:在执行任务之前,一定要准备好工具、目标和流程

使用工具:暗影刀 RPA

目标:抓取老板直聘中RPA的工作清单数据网站

流程图:

第一步:打开网页

第 2 步:输入关键字

填写输入框(web):我们需要告诉工具输入框在哪里,所以我们需要捕获输入框

第三部分:点击搜索

点击元素(web):我们需要告诉工具搜索按钮在哪里,所以我们需要捕获搜索按钮

第 4 步:显示结果

注意:这里使用等待两秒等待数据显示,这是保证流程顺利执行的保证条件之一。未来会有更深入的解释,使用各种方法来提高过程的鲁棒性。

第 5 步:数据捕获

这里我们需要抓取相似的元素来确定数据规则,比如职位:RPA开发工程师,它位于网页列表中的固定位置,我们只需要抓取两个不同的职位,告诉工具我们想要获取有关此元素的信息。

注意:必须是类似的元素,比如上图中的“RPA开发工程师”和“RPA开发负责人”,这样我们才能抓取页面上的所有职位信息,如下图:

当然,我们也可以抓取其他元素,只要添加一个新列,然后抓取两次元素,记住,一定是两个不同但相似的元素。

这样,我们通过5个步骤抓取了网页的数据。我这里写的比较详细,其实不到一分钟就写完了。

以上就是网站数据采集软件(如何采集网页数据)的相关内容,更多精彩我们

抓取网页数据(程序员网页数据爬取程序的几种解决方案:服务器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-03-27 14:11

摘要:对于程序员或开发人员来说,拥有编程能力可以让他们轻松有趣地构建网络数据抓取程序。但是对于大多数没有任何编程知识的人来说,最好使用一些网络爬虫软件从特定网页中获取特定内容。程序员

网页数据抓取是指从网站中提取特定内容,而不需要请求网站的API接口来获取内容。“网页数据”是网站用户体验的一部分,例如网页上的文字、图像、声音、视频和动画等,都是网页数据。编程

对于程序员或开发人员来说,拥有编程技能可以轻松有趣地构建网络抓取程序。但是对于大多数没有任何编程知识的人来说,最好使用一些网络爬虫软件从特定网页中获取特定内容。以下是一些使用 优采云采集器 抓取 Web 数据的解决方案: 服务器

一、从动态网页中提取内容网络

网页可以是静态的或动态的。一般来说,您要提取的网页内容会随着您访问 网站 的时间而改变。通常,这个 网站 是一个动态的网站,它使用 AJAX 或其他技术来使 Web 内容保持最新。AJAX 是一种延迟加载和异步更新的脚本技术。在后台与服务器进行少量数据交换后,可以更新网页的某个部分,而无需重新加载整个网页。异步

性能特点是当点击网页中的某个选项时,网站的大部分URL不会改变;网页没有完全加载,而只是部分加载了数据,这些数据会发生变化。这时候可以在优采云的“高级选项”元素的“Ajax加载”中进行设置,然后就可以抓取Ajax加载的网页数据了。工具

二、从网页中抓取隐藏的内容动画

你有没有想过从 网站 获取特定的数据,但是当你触发连接或将鼠标悬停在某个地方时,内容就会出现?例如下图中的网站,需要将鼠标移到选中的彩票上,才能显示类别。对于这个功能,可以设置为“将鼠标移到这个连接上”,可以抓取网页中隐藏的内容。. 网站

三、从无限滚动的网页中提取内容视频

滚动到页面底部后,一些 网站 将只显示您要提取的部分数据。比如在今日头条首页,需要不断滚动到页面底部才能加载更多文章内容。无限滚动 网站 通常使用 AJAX 或 JavaScript 从 网站 请求额外的内容。在这种情况下,您可以设置 AJAX 超时设置并选择滚动方式和滚动时间以从网页中提取内容。博客

四、 从网络上抓取所有链接

一个普通的 网站 将收录至少一个超链接。如果要提取网页中的所有链接,可以使用 优采云 获取网页上发布的所有超链接。

五、从网页中抓取所有文本

有时您需要提取 HTML 文档中的整个文本,即将其放置在 HTML 标记中(例如

标签或标签)。优采云允许您从网页的源代码中提取所有或特定文本。

六、从网上抓取所有图片

有的朋友有采集网页图片的需求。优采云可以下载网页中图片的URL采集,然后下载使用优采云专用的图片批量下载工具,可以下载我们提供的图片URL中的图片采集 到。下载并保存到本地计算机。 查看全部

抓取网页数据(程序员网页数据爬取程序的几种解决方案:服务器)

摘要:对于程序员或开发人员来说,拥有编程能力可以让他们轻松有趣地构建网络数据抓取程序。但是对于大多数没有任何编程知识的人来说,最好使用一些网络爬虫软件从特定网页中获取特定内容。程序员

网页数据抓取是指从网站中提取特定内容,而不需要请求网站的API接口来获取内容。“网页数据”是网站用户体验的一部分,例如网页上的文字、图像、声音、视频和动画等,都是网页数据。编程

对于程序员或开发人员来说,拥有编程技能可以轻松有趣地构建网络抓取程序。但是对于大多数没有任何编程知识的人来说,最好使用一些网络爬虫软件从特定网页中获取特定内容。以下是一些使用 优采云采集器 抓取 Web 数据的解决方案: 服务器

一、从动态网页中提取内容网络

网页可以是静态的或动态的。一般来说,您要提取的网页内容会随着您访问 网站 的时间而改变。通常,这个 网站 是一个动态的网站,它使用 AJAX 或其他技术来使 Web 内容保持最新。AJAX 是一种延迟加载和异步更新的脚本技术。在后台与服务器进行少量数据交换后,可以更新网页的某个部分,而无需重新加载整个网页。异步

性能特点是当点击网页中的某个选项时,网站的大部分URL不会改变;网页没有完全加载,而只是部分加载了数据,这些数据会发生变化。这时候可以在优采云的“高级选项”元素的“Ajax加载”中进行设置,然后就可以抓取Ajax加载的网页数据了。工具

二、从网页中抓取隐藏的内容动画

你有没有想过从 网站 获取特定的数据,但是当你触发连接或将鼠标悬停在某个地方时,内容就会出现?例如下图中的网站,需要将鼠标移到选中的彩票上,才能显示类别。对于这个功能,可以设置为“将鼠标移到这个连接上”,可以抓取网页中隐藏的内容。. 网站

三、从无限滚动的网页中提取内容视频

滚动到页面底部后,一些 网站 将只显示您要提取的部分数据。比如在今日头条首页,需要不断滚动到页面底部才能加载更多文章内容。无限滚动 网站 通常使用 AJAX 或 JavaScript 从 网站 请求额外的内容。在这种情况下,您可以设置 AJAX 超时设置并选择滚动方式和滚动时间以从网页中提取内容。博客

四、 从网络上抓取所有链接

一个普通的 网站 将收录至少一个超链接。如果要提取网页中的所有链接,可以使用 优采云 获取网页上发布的所有超链接。

五、从网页中抓取所有文本

有时您需要提取 HTML 文档中的整个文本,即将其放置在 HTML 标记中(例如

标签或标签)。优采云允许您从网页的源代码中提取所有或特定文本。

六、从网上抓取所有图片

有的朋友有采集网页图片的需求。优采云可以下载网页中图片的URL采集,然后下载使用优采云专用的图片批量下载工具,可以下载我们提供的图片URL中的图片采集 到。下载并保存到本地计算机。

抓取网页数据(风铃虫的核心数源码,网页下载器及其依赖新增selenium相关组件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-03-27 14:09

wind-bell 是一款轻量级的爬虫工具,灵敏如风铃,敏捷如蜘蛛,可感知任何小风箱和小草,轻松抓取网络内容。是一个对目标服务器比较友好的爬虫程序。它内置了20多个常用或不常用的浏览器标识符,可自动处理cookies和网页源信息,轻松绕过服务器限制,智能调整请求间隔,动态调整请求频率,防止干扰目标服务器。此外,bellworm 对于普通用户来说也是一个非常友好的工具。它提供了大量的链接提取器和内容提取器,让用户可以快速随心所欲地配置,甚至可以通过提供起始请求地址来配置自己的爬虫程序。同时,bellworm还开放了很多自定义界面,让高级用户可以根据自己的需要自定义爬虫功能。最后,蓝铃还天然支持分布式和集群功能,让你突破单机环境的束缚,释放你的爬取能力。可以说,铃虫几乎可以抢到当前所有网站中的大部分内容。

本次更新内容如下:

移除 Httpclient 网页下载器及其依赖 添加 selenium 相关组件,允许用户自定义 selenium 下载器的实现 添加 SeleniumDownloader 下载器,可下载前端渲染网页 添加资源回收功能,当 bellworm 实例时自动回收下载器停止资源修复网页SEO信息中关键字提取异常的问题。添加内置代码提取器,自动提取网页代码信息。修改请求间隔时间单位和超时等待时间规则属性,使控制能力更加精准。增加了关闭请求间隔时间的功能,控制可以更灵活的增加非法链接过滤功能,自动过滤非法链接,提高爬取效率,

源地址:

API 文档: 查看全部

抓取网页数据(风铃虫的核心数源码,网页下载器及其依赖新增selenium相关组件)

wind-bell 是一款轻量级的爬虫工具,灵敏如风铃,敏捷如蜘蛛,可感知任何小风箱和小草,轻松抓取网络内容。是一个对目标服务器比较友好的爬虫程序。它内置了20多个常用或不常用的浏览器标识符,可自动处理cookies和网页源信息,轻松绕过服务器限制,智能调整请求间隔,动态调整请求频率,防止干扰目标服务器。此外,bellworm 对于普通用户来说也是一个非常友好的工具。它提供了大量的链接提取器和内容提取器,让用户可以快速随心所欲地配置,甚至可以通过提供起始请求地址来配置自己的爬虫程序。同时,bellworm还开放了很多自定义界面,让高级用户可以根据自己的需要自定义爬虫功能。最后,蓝铃还天然支持分布式和集群功能,让你突破单机环境的束缚,释放你的爬取能力。可以说,铃虫几乎可以抢到当前所有网站中的大部分内容。

本次更新内容如下:

移除 Httpclient 网页下载器及其依赖 添加 selenium 相关组件,允许用户自定义 selenium 下载器的实现 添加 SeleniumDownloader 下载器,可下载前端渲染网页 添加资源回收功能,当 bellworm 实例时自动回收下载器停止资源修复网页SEO信息中关键字提取异常的问题。添加内置代码提取器,自动提取网页代码信息。修改请求间隔时间单位和超时等待时间规则属性,使控制能力更加精准。增加了关闭请求间隔时间的功能,控制可以更灵活的增加非法链接过滤功能,自动过滤非法链接,提高爬取效率,

源地址:

API 文档:

抓取网页数据(Python爬虫架构详细分析及调度器的一个应用方法介绍 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-03-23 00:07

)

Python爬虫架构主要由五部分组成,分别是调度器、URL管理器、网页下载器、网页解析器和应用程序(爬取有价值的数据)。

调度器:相当于一台计算机的CPU,主要负责调度URL管理器、下载器、解析器之间的协调。

URL管理器:包括要爬取的URL地址和已经爬取的URL地址,防止URL重复爬取和URL循环爬取。实现 URL 管理器的方式主要有 3 种:内存、数据库和缓存数据库。

网页下载器:通过传入 URL 地址下载网页并将网页转换为字符串。网页下载器有urllib2(Python官方基础模块),包括需要登录、代理和cookies、requests(第三方包)

网页解析器:通过解析一个网页字符串,可以根据我们的需求提取我们有用的信息,或者按照DOM树的解析方式进行解析。网页解析器有正则表达式(直观地说,就是将网页转换成字符串,通过模糊匹配提取有价值的信息,当文档比较复杂时,这种方法提取数据会很困难),html。parser(Python自带),beautifulsoup(第三方插件,可以使用Python自带的html.parser解析,也可以使用lxml,比别人更强大),lxml(第三方插件) ,可以解析xml和HTML),html.parser和beautifulsoup和lxml都是用DOM树的方式解析的。

应用程序:它是由从网页中提取的有用数据组成的应用程序。

1.爬虫入门程序

首先,我们调用urllib2库中的urlopen方法,传入一个URL。这个网址是百度主页,协议是HTTP协议。当然你也可以把HTTP换成FTP、FILE、HTTPS等,只是代表一种访问。控制协议,

urlopen一般接受三个参数,其参数如下: urlopen(url, data, timeout) 第一个参数url是URL,

第二个参数data是访问URL时要传输的数据,

第三次超时是设置超时时间。

第二个和第三个参数不能传送。data的默认值为None,timeout的默认值为socket._GLOBAL_DEFAULT_TIMEOUT。必须传输第一个参数 URL。在这个例子中,我们传输百度的 URL。执行 urlopen 方法后,返回一个响应对象,返回的信息存储在其中。

#导入功能库 urllib2

import urllib2

#调用urllib2库的urlopen方法 第一个参数url即为URL

response = urllib2.urlopen("http://www.baidu.com")

#response 对象有一个 read 方法,可以返回获取到的网页内容。

print response.read()

2.爬虫添加数据,headers,然后post请求

我们介绍了urllib库,现在我们模拟登录CSDN。当然,上面的代码可能无法登录,因为CSDN也有序列号字段,没有完全设置,所以比较复杂,这里就不写了。原则。一般登录网站一般都是这样写的。我们需要定义一个名为values的字典,参数我设置的用户名和密码,下面使用urllib的urlencode方法对字典进行编码,命名为data。构造请求时,传入url和data两个参数,运行程序,返回的是POST后渲染的页面内容。注意上面的字典还有另一种定义方式,下面的写法是等价的

有的网站会不允许程序以上述方式直接访问。如果识别有问题,网站根本不会响应,所以为了完全模拟浏览器的工作,我们需要设置一些Headers属性。首先打开我们的浏览器,调试浏览器F12,我用的是Chrome,打开网络监控,提示如下,如知乎,登录后我们会发现界面变了登录,和一个新的,本质上,这个页面收录了很多内容。这些内容不是一次加载的。实际上,执行了许多请求。一般是先请求HTML文件,再加载JS、CSS等。经过多次请求,网页的骨架和肌肉都完成了,整个网页的效果就出来了。

#导入功能库库名 urllib urllib2

import urllib

import urllib2

#填写地址url

url = 'http://www.server.com/login'

#设置Headers 的参数

user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'

#设置data 参数是访问URL时要传送的数据

values = {'username' : 'cqc', 'password' : 'XXXX' }

#设置Headers 的属性

headers = { 'User-Agent' : user_agent }

#对data数据进行编码

data = urllib.urlencode(values)

#进行请求

request = urllib2.Request(url, data, headers)

#进行访问

response = urllib2.urlopen(request)

#返回获取到的网页内容

page = response.read()

3.爬虫添加cookie

cookielib 模块的主要作用是提供可以存储cookie 的对象,供urllib2 模块使用以访问Internet 资源。Cookielib 模块非常强大,我们可以使用该模块的 CookieJar 类的对象来捕获 cookie 并在后续的连接请求中重新发送,例如模拟登录的能力。该模块的主要对象是 CookieJar、FileCookieJar、MozillaCookieJar、LWPCookieJar。它们的关系:CookieJar -- 派生 --> FileCookieJar -- 派生 --> MozillaCookieJar 和 LWPCookieJar

import urllib

import urllib2

import cookielib

filename = 'cookie.txt'

#声明一个MozillaCookieJar对象实例来保存cookie,之后写入文件

cookie = cookielib.MozillaCookieJar(filename)

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))

postdata = urllib.urlencode({

'stuid':'201200131012',

'pwd':'23342321'

})

#登录教务系统的URL

loginUrl = 'http://jwxt.sdu.edu.cn:7890/pl ... 39%3B

#模拟登录,并把cookie保存到变量

result = opener.open(loginUrl,postdata)

#保存cookie到cookie.txt中

cookie.save(ignore_discard=True, ignore_expires=True)

#利用cookie请求访问另一个网址,此网址是成绩查询网址

gradeUrl = 'http://jwxt.sdu.edu.cn:7890/pl ... 39%3B

#请求访问成绩查询网址

result = opener.open(gradeUrl)

print result.read()

4.正则表达式

Python中re模块的主要作用是使用正则表达式来匹配和处理字符串。import 重新导入模块后,可以使用模块下的所有方法和属性

import re

#定义正则化规则=匹配模式,r表示原生字符串

pattern=re.compile(r"hello")

#匹配文本

# result1=re.search(pattern,"hello hello");

# # print(result1)

result1=re.match(pattern,"hello hello")

print(result1)

#点代表任意字符

pattern2=re.compile(r'a.c')

result2=re.match(pattern2,'abcdefgg')

print(result2)

#\转义字符

pattern3=re.compile(r'a\.c')

result3=re.match(pattern3,'a.cdefgg')

print(result3)

#[...]字符串中间包含 -包含 ^不包含

pattern4=re.compile(r"a[a-z,A-z]bc")

result4=re.match(pattern4,r'aabcv')

print(result4)

#\d数字 \D不是数字

pattern6=re.compile(r"a\dbc")

result6=re.match(pattern6,'a6bcdd')

print(result6)

#\s空白字符 \S不是空白字符

pattern7=re.compile(r"a\sbc")

result7=re.match(pattern7,'a bcdd')

print(result7)

#\w 单词字符[A-Z,a-z,0-9] \W非单词字符

pattern8=re.compile(r"a\wbc")

result8=re.match(pattern8,'a bcdd')

print(result8)

#匹配邮箱

pattern9=re.compile(r"\d+@\w+\.\w+")

result9=re.search(pattern9,"1231qw@qq.com")

print(result9)

#*表示0个或者无无限次

rexg=re.compile(r'\d*\w*')

res=re.search(rexg,'1dddd')

print(res)

#+前一个字符一次或者无限次

rexg=re.compile(r'\d+\w')

res=re.search(rexg,'1dddd')

print(res)

#?表示一个或者0个

rexg=re.compile(r'\d?ddd')

res=re.search(rexg,'123dddd')

res2=re.match(rexg,'123dddd')

print(res)

print(res2)

#{m}匹配前一个字符m个

rexg=re.compile(r'1\d{10}')

res=re.search(rexg,'16666666666')

print(res)

#{m,n}m至n次

rexg=re.compile(r'\d{5,12}@\w{2}\.\w{3}')

res=re.search(rexg,'1436619325@qq.com')

print(res)

#非贪恋模式

rexg=re.compile(r'\d{5,10}?')

res=re.search(rexg,'1436619325')

print(res)

#^字符串开头支持多行

rexg=re.compile(r'^abc')

res=re.search(rexg,'abc123')

print(res)

#$字符串结尾支持多行

rexg=re.compile(r'abc$')

res=re.search(rexg,'123abc')

print(res)

#\A字符串结尾支持多行

rexg=re.compile(r'\Aabc')

res=re.search(rexg,'abc123')

print(res)

#\z字符串结尾支持多行

rexg=re.compile(r'abc\Z')

res=re.search(rexg,'123abc')

print(res)

#|满足任意提交

rexg=re.compile(r'1\d{10}|d{5,12}@qq\.com')

res=re.search(rexg,'dsafsd13424234324234sssss111111111111@qq.com')

print(res)

#分组

rexg=re.compile(r'(abc){3}')

res=re.search(rexg,'abcabcabcss')

print(res)

#分组+别名

rexg=re.compile(r'(?Pabc)88(?P=tt)')

res=re.search(rexg,'abcabc88abcss')

print(res)

#分组+编号

rexg=re.compile(r'(\d{3})uu\1')

res=re.search(rexg,'123uu123')

print(res) 查看全部

抓取网页数据(Python爬虫架构详细分析及调度器的一个应用方法介绍

)

Python爬虫架构主要由五部分组成,分别是调度器、URL管理器、网页下载器、网页解析器和应用程序(爬取有价值的数据)。

调度器:相当于一台计算机的CPU,主要负责调度URL管理器、下载器、解析器之间的协调。

URL管理器:包括要爬取的URL地址和已经爬取的URL地址,防止URL重复爬取和URL循环爬取。实现 URL 管理器的方式主要有 3 种:内存、数据库和缓存数据库。

网页下载器:通过传入 URL 地址下载网页并将网页转换为字符串。网页下载器有urllib2(Python官方基础模块),包括需要登录、代理和cookies、requests(第三方包)

网页解析器:通过解析一个网页字符串,可以根据我们的需求提取我们有用的信息,或者按照DOM树的解析方式进行解析。网页解析器有正则表达式(直观地说,就是将网页转换成字符串,通过模糊匹配提取有价值的信息,当文档比较复杂时,这种方法提取数据会很困难),html。parser(Python自带),beautifulsoup(第三方插件,可以使用Python自带的html.parser解析,也可以使用lxml,比别人更强大),lxml(第三方插件) ,可以解析xml和HTML),html.parser和beautifulsoup和lxml都是用DOM树的方式解析的。

应用程序:它是由从网页中提取的有用数据组成的应用程序。

1.爬虫入门程序

首先,我们调用urllib2库中的urlopen方法,传入一个URL。这个网址是百度主页,协议是HTTP协议。当然你也可以把HTTP换成FTP、FILE、HTTPS等,只是代表一种访问。控制协议,

urlopen一般接受三个参数,其参数如下: urlopen(url, data, timeout) 第一个参数url是URL,

第二个参数data是访问URL时要传输的数据,

第三次超时是设置超时时间。

第二个和第三个参数不能传送。data的默认值为None,timeout的默认值为socket._GLOBAL_DEFAULT_TIMEOUT。必须传输第一个参数 URL。在这个例子中,我们传输百度的 URL。执行 urlopen 方法后,返回一个响应对象,返回的信息存储在其中。

#导入功能库 urllib2

import urllib2

#调用urllib2库的urlopen方法 第一个参数url即为URL

response = urllib2.urlopen("http://www.baidu.com";)

#response 对象有一个 read 方法,可以返回获取到的网页内容。

print response.read()

2.爬虫添加数据,headers,然后post请求

我们介绍了urllib库,现在我们模拟登录CSDN。当然,上面的代码可能无法登录,因为CSDN也有序列号字段,没有完全设置,所以比较复杂,这里就不写了。原则。一般登录网站一般都是这样写的。我们需要定义一个名为values的字典,参数我设置的用户名和密码,下面使用urllib的urlencode方法对字典进行编码,命名为data。构造请求时,传入url和data两个参数,运行程序,返回的是POST后渲染的页面内容。注意上面的字典还有另一种定义方式,下面的写法是等价的

有的网站会不允许程序以上述方式直接访问。如果识别有问题,网站根本不会响应,所以为了完全模拟浏览器的工作,我们需要设置一些Headers属性。首先打开我们的浏览器,调试浏览器F12,我用的是Chrome,打开网络监控,提示如下,如知乎,登录后我们会发现界面变了登录,和一个新的,本质上,这个页面收录了很多内容。这些内容不是一次加载的。实际上,执行了许多请求。一般是先请求HTML文件,再加载JS、CSS等。经过多次请求,网页的骨架和肌肉都完成了,整个网页的效果就出来了。

#导入功能库库名 urllib urllib2

import urllib

import urllib2

#填写地址url

url = 'http://www.server.com/login'

#设置Headers 的参数

user_agent = 'Mozilla/4.0 (compatible; MSIE 5.5; Windows NT)'

#设置data 参数是访问URL时要传送的数据

values = {'username' : 'cqc', 'password' : 'XXXX' }

#设置Headers 的属性

headers = { 'User-Agent' : user_agent }

#对data数据进行编码

data = urllib.urlencode(values)

#进行请求

request = urllib2.Request(url, data, headers)

#进行访问

response = urllib2.urlopen(request)

#返回获取到的网页内容

page = response.read()

3.爬虫添加cookie

cookielib 模块的主要作用是提供可以存储cookie 的对象,供urllib2 模块使用以访问Internet 资源。Cookielib 模块非常强大,我们可以使用该模块的 CookieJar 类的对象来捕获 cookie 并在后续的连接请求中重新发送,例如模拟登录的能力。该模块的主要对象是 CookieJar、FileCookieJar、MozillaCookieJar、LWPCookieJar。它们的关系:CookieJar -- 派生 --> FileCookieJar -- 派生 --> MozillaCookieJar 和 LWPCookieJar

import urllib

import urllib2

import cookielib

filename = 'cookie.txt'

#声明一个MozillaCookieJar对象实例来保存cookie,之后写入文件

cookie = cookielib.MozillaCookieJar(filename)

opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cookie))