抓取网页数据(如何从网站爬网数据中获取结构化数据?() )

优采云 发布时间: 2022-04-09 19:24抓取网页数据(如何从网站爬网数据中获取结构化数据?()

)

原创来源:Works (3 Best Ways to Scrape Data from 网站) / 网站 Name (Octoparse)

原创链接:从网站抓取数据的最佳 3 种方法

在过去的几年里,抓取数据的需求变得越来越大。爬取的数据可用于不同领域的评估或预测。在这里,我想谈谈我们可以采取的三种方法来从 网站 爬取数据。

1.使用网站API

许多大型社交媒体 网站,例如 Facebook、Twitter、Instagram、StackOverflow,都提供 API 供用户访问他们的数据。有时,您可以选择官方 API 来获取结构化数据。如下面的 Facebook Graph API 所示,您需要选择要查询的字段,然后对数据进行排序、执行 URL 查找、发出请求等。要了解更多信息,请参阅 /docs/graph-api/using-graph-api。

2.构建自己的爬虫

但是,并非所有 网站 都向用户提供 API。部分网站由于技术限制或其他原因拒绝提供任何公共API。有人可能会提出 RSS 提要,但由于使用受限,我不会建议或评论它们。在这种情况下,我想讨论的是,我们可以构建自己的爬虫来处理这种情况。

爬虫如何工作?换句话说,爬虫是一种生成可以由提取器提供的 URL 列表的方法。爬虫可以定义为查找 URL 的工具。首先,您为爬虫提供一个要启动的网页,它们会跟随该页面上的所有链接。然后该过程将继续循环。

然后,我们可以继续构建自己的爬虫。众所周知,Python 是一种开源编程语言,您可以找到许多有用的函数库。这里我推荐 BeautifulSoup(一个 Python 库),因为它易于使用并且具有许多直观的字符。更准确地说,我将使用两个 Python 模块来抓取数据。

BeautifulSoup 无法为我们获取网页。这就是我将 urllib2 与 BeautifulSoup 库一起使用的原因。然后我们需要处理 HTML 标记以找到页面标记和右表中的所有链接。之后,遍历每一行 (tr) 并将 tr (td) 的每个元素分配给一个变量并将其附加到列表中。首先我们看一下表格的HTML结构(我不会提取表格头信息)。

通过采用这种方法,您的爬虫是定制的。它可以处理API提取中遇到的一些困难。您可以使用代理来防止它被某些 网站 等阻止。整个过程在您的控制范围内。这种方法对于具有编码技能的人应该是有意义的。您抓取的数据框应如下图所示。

3.使用现成的爬虫工具

但是,以编程方式自行抓取 网站 网络可能会很耗时。对于没有任何编码技能的人来说,这将是一项艰巨的任务。因此,我想介绍一些爬虫工具。

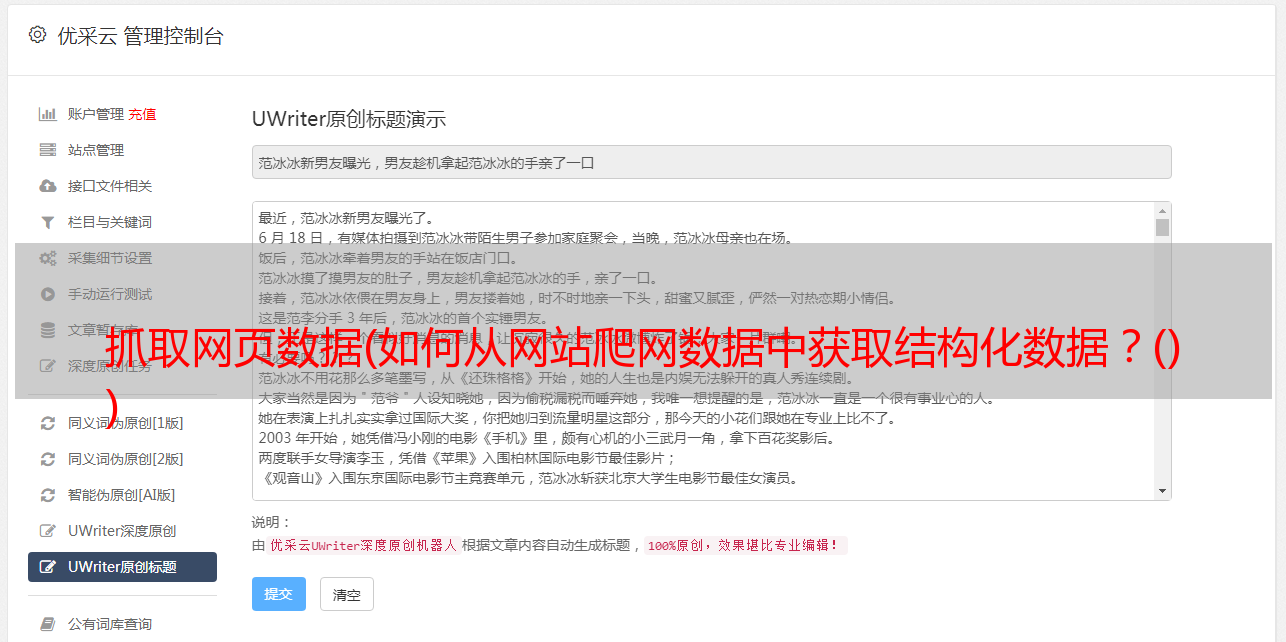

八度分析

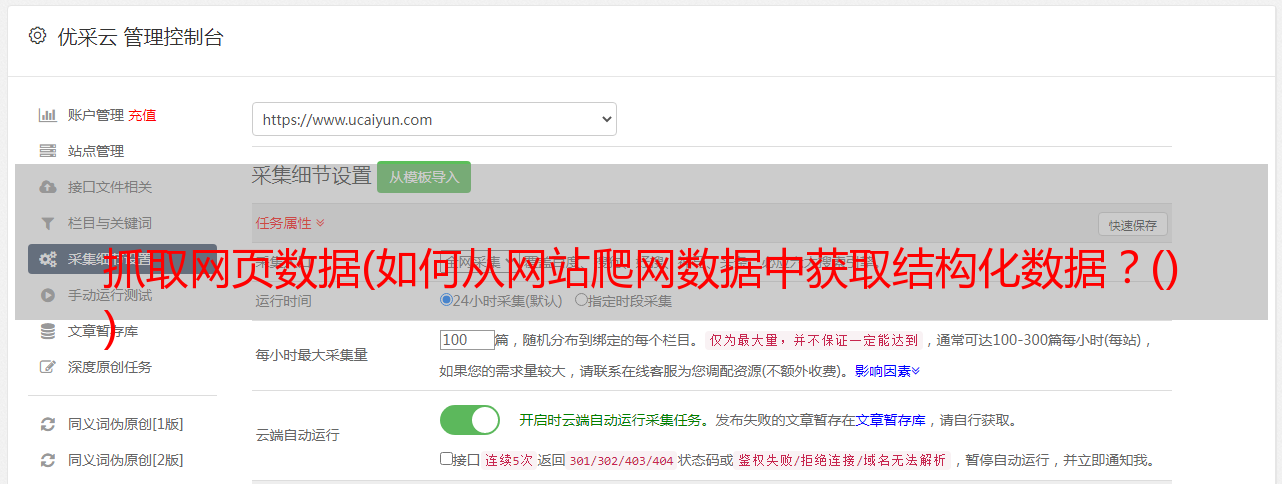

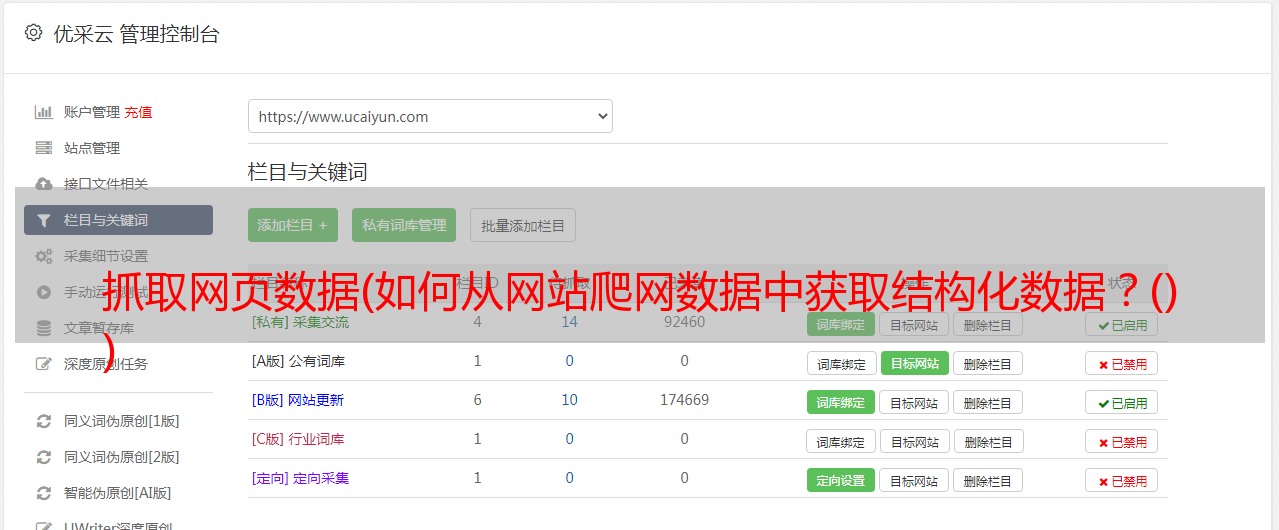

Octoparse 是一个强大的基于 Visual Windows 的网络数据爬虫。用户可以使用其简单友好的用户界面轻松掌握此工具。要使用它,您需要在本地桌面上下载此应用程序。

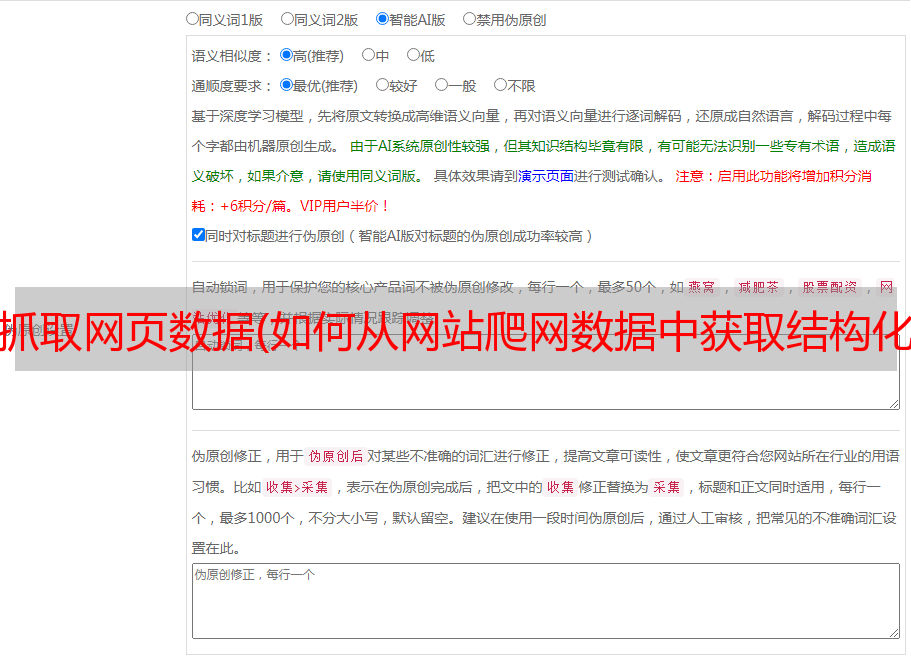

如下图所示,您可以在 Workflow Designer 窗格中单击并拖动这些块来自定义您自己的任务。Octoparse 提供两种版本的爬虫服务订阅计划——免费和付费。两者都可以满足用户基本的刮或刮需求。使用免费版本,您可以在本地运行任务。

如果您将免费版切换到付费版,您可以通过将任务上传到云平台来使用基于云的服务。6 到 14 台云服务器将同时以更高的速度运行您的任务,并在更广泛的范围内爬行。此外,您可以使用 Octoparse 的匿名代理功能自动提取数据而不留下任何痕迹,该功能可以轮流使用大量 IP,从而可以防止您被某些 网站 阻止。这是一个介绍 Octoparse 云提取的视频。

Octoparse 还提供 API 以将您的系统实时连接到您抓取的数据。您可以将 Octoparse 数据导入您自己的数据库或使用 API 请求访问您帐户的数据。完成任务配置后,您可以将数据导出为CSV、Excel、HTML、TXT和数据库(MySQL、SQL Server和Oracle)等多种格式。

*敏*感*词*

Import.io,也称为网络爬虫,涵盖了所有不同级别的爬虫需求。它提供了一个神奇的工具,无需任何培训即可将站点转换为表格。对于更复杂的 网站 爬取,建议用户下载他们的桌面应用程序。构建 API 后,它们会提供许多简单的集成选项,例如 Google Sheets、Plot.ly、Excel 以及 GET 和 POST 请求。当您考虑到所有这些都伴随着终生免费的价格标签和强大的支持团队时,import.io 无疑是那些寻找结构化数据的人的首选。他们还为寻求更*敏*感*词*或更复杂数据提取的公司提供企业级付费选项。

本山达

Mozenda 是另一个用户友好的网络数据提取器。它为用户提供点击式 UI,无需任何编码技能即可使用。Mozenda 还消除了自动化和发布提取数据的麻烦。一次告诉 Mozenda 您想要什么数据,然后根据需要多次获取。此外,它允许使用 REST API 进行高级编程,用户可以直接连接 Mozenda 帐户。它还提供基于云的服务以及 IP 轮换。

刮框

搜索引擎优化专家、在线营销人员甚至垃圾邮件发送者应该对 ScrapeBox 非常熟悉,它具有非常人性化的界面。用户可以轻松地从 网站 采集数据以获取电子邮件、检查页面排名、验证工作代理和 RSS 提交。通过使用数以千计的轮换代理,您将能够隐藏竞争对手的 网站 关键字、对 .gov网站 进行研究、采集数据并发表评论,而不会被阻止或检测到。

谷歌网络爬虫插件

如果人们只是想以一种简单的方式抓取数据,我建议您选择 Google Web Scraper 插件。它是一个基于浏览器的网络爬虫,其工作方式类似于 Firefox 的 Outwit Hub。您可以将其作为扩展程序下载并安装在浏览器中。您需要突出显示要抓取的数据字段,右键单击并选择“Scrape like...”。与您突出显示的内容类似的任何内容都将呈现在一个准备导出的表格中,并且与 Google Docs 兼容。最新版本的电子表格仍有一些错误。虽然它操作简单,但它应该是所有用户都应该注意的,但它不能大量抓取图像和抓取数据。