抓取网页数据

抓取网页数据( 网站优化之规范代码规范化换行的Html代码对一个网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-03-11 12:19

网站优化之规范代码规范化换行的Html代码对一个网站)

网站优化的标准HTML代码

规范化的 Html 代码对于 网站 有很多好处,例如:易于修改、易于代码维护、代码量大

如何优化 HTML网站 代码

一个高质量的网站,网站代码的优化是非常重要的。对于一个好的SEO人来说,虽然不需要精通代码,但是一些简单的基本代码还是需要懂的。要想成为优秀的SEO人眼,需要有不断学习的精神。我们的网站 中的某个页面需要网站 代码优化。如果想看懂代码,可以给网站的添加附加值,有利于蜘蛛爬网

增长知识!网站哪些html代码需要针对seo进行优化?

关于seo,大部分人看到的界面都是用html代码组织的。优化网站html代码的目的是为了让网站更适合搜索引擎。精致的网站一端适合用户,另一端适合

git 拉取代码到本地

git拉码到本地的方法是:先打开git命令窗口,输入命令【gitclonegithub仓库地址】;然后回车拉码到本地仓库。第一步:拉取远程代码 gitclone

如何在html中直接显示html代码

本文文章将介绍在html中直接显示html代码的方式。有一定的参考价值,有需要的朋友可以参考,希望对大家有所帮助。百度做了很多实践,感觉很多都没有测试过就废话了。

如何编写html换行代码

html换行代码是“

",在要换行的行末尾,添加"

《代码可以实现换行操作.html》

”标签用于插入简单的换行符,实现换行。本教程运行环境:win

关于精简网站代码优化技巧

在网站的基础seo优化中,精简CSS代码和精简HTML代码是一项重要的优化技术。代码的简化直接影响到搜索引擎爬取网站的效果,因为搜索引擎爬取的第一步是网站的文章内容。严重影响搜索引擎抓取文章内容的效果。代码简化后,不仅可以增加网站的文字内容比例,还可以

关于精简网站代码优化技巧

在网站的基础seo优化中,精简CSS代码和精简HTML代码是一项重要的优化技术。代码的简化直接影响到搜索引擎爬取网站的效果,因为搜索引擎爬取的第一步是网站的文章内容。严重影响搜索引擎抓取文章内容的效果。代码简化后,不仅可以增加网站的文字内容比例,还可以

html中的空格代码是什么

HTML空格码就是HTML空格字符码,由“&+n+b+s+p+;”组成,记住最后一个分号不要忘记。在 CSS 中,当 white-space 属性的值为 pre 时,浏览器会在文本中保留空格和换行符,例如:

如何在vscode中运行html代码

本文文章将介绍在vscode中运行html代码的方式。有一定的参考价值,有需要的朋友可以参考,希望对大家有所帮助。如何在vscode中运行html代码:点击vscode软件左侧的扩展

html常用代码

1:粗斜体代码 ◆粗体代码为:Hello ◆斜体代码为:Hello!◆底线字: 2:文本链接代码 如果你想点击某个文本连接到另一个网页,这是一个超链接,代码如下: 如果你在共享空间中点击这个文本并重新打开一个窗口,代码是:

如何在html中注释代码

html中注释代码的方法:先修改文件名,完善代码;然后创建三个div层,并使用“”进行注释;最后刷新网页。本教程的运行环境:windows7系统,html5版本,DELLG3电脑。用于注释的 html 中的代码

jquery如何输出html代码

jquery输出html代码的方法:1、直接输出tag元素,代码为[varform1=""];2、 输出带有变量的标签元素,代码为[varcountry=....]。杰克

为什么html看不到php代码

html看不到php代码,因为所有的php代码都是在网站发送到浏览器之前在服务器上执行的,而浏览器接收到的一切都是php嵌入到html中的结果。本文运行环境:windows7系统,PHP7.第1版,DELLG3

如何善用博客或网站上的标签?

用于博客和 网站 的强大但未充分利用的工具之一是标记页面或博客文章。有效地使用标签并不容易。在这篇文章中,我将通过几个例子来说明如何使用标签来充分利用它们,以及需要注意的问题和一些高级策略。 查看全部

抓取网页数据(

网站优化之规范代码规范化换行的Html代码对一个网站)

网站优化的标准HTML代码

规范化的 Html 代码对于 网站 有很多好处,例如:易于修改、易于代码维护、代码量大

如何优化 HTML网站 代码

一个高质量的网站,网站代码的优化是非常重要的。对于一个好的SEO人来说,虽然不需要精通代码,但是一些简单的基本代码还是需要懂的。要想成为优秀的SEO人眼,需要有不断学习的精神。我们的网站 中的某个页面需要网站 代码优化。如果想看懂代码,可以给网站的添加附加值,有利于蜘蛛爬网

增长知识!网站哪些html代码需要针对seo进行优化?

关于seo,大部分人看到的界面都是用html代码组织的。优化网站html代码的目的是为了让网站更适合搜索引擎。精致的网站一端适合用户,另一端适合

git 拉取代码到本地

git拉码到本地的方法是:先打开git命令窗口,输入命令【gitclonegithub仓库地址】;然后回车拉码到本地仓库。第一步:拉取远程代码 gitclone

如何在html中直接显示html代码

本文文章将介绍在html中直接显示html代码的方式。有一定的参考价值,有需要的朋友可以参考,希望对大家有所帮助。百度做了很多实践,感觉很多都没有测试过就废话了。

如何编写html换行代码

html换行代码是“

",在要换行的行末尾,添加"

《代码可以实现换行操作.html》

”标签用于插入简单的换行符,实现换行。本教程运行环境:win

关于精简网站代码优化技巧

在网站的基础seo优化中,精简CSS代码和精简HTML代码是一项重要的优化技术。代码的简化直接影响到搜索引擎爬取网站的效果,因为搜索引擎爬取的第一步是网站的文章内容。严重影响搜索引擎抓取文章内容的效果。代码简化后,不仅可以增加网站的文字内容比例,还可以

关于精简网站代码优化技巧

在网站的基础seo优化中,精简CSS代码和精简HTML代码是一项重要的优化技术。代码的简化直接影响到搜索引擎爬取网站的效果,因为搜索引擎爬取的第一步是网站的文章内容。严重影响搜索引擎抓取文章内容的效果。代码简化后,不仅可以增加网站的文字内容比例,还可以

html中的空格代码是什么

HTML空格码就是HTML空格字符码,由“&+n+b+s+p+;”组成,记住最后一个分号不要忘记。在 CSS 中,当 white-space 属性的值为 pre 时,浏览器会在文本中保留空格和换行符,例如:

如何在vscode中运行html代码

本文文章将介绍在vscode中运行html代码的方式。有一定的参考价值,有需要的朋友可以参考,希望对大家有所帮助。如何在vscode中运行html代码:点击vscode软件左侧的扩展

html常用代码

1:粗斜体代码 ◆粗体代码为:Hello ◆斜体代码为:Hello!◆底线字: 2:文本链接代码 如果你想点击某个文本连接到另一个网页,这是一个超链接,代码如下: 如果你在共享空间中点击这个文本并重新打开一个窗口,代码是:

如何在html中注释代码

html中注释代码的方法:先修改文件名,完善代码;然后创建三个div层,并使用“”进行注释;最后刷新网页。本教程的运行环境:windows7系统,html5版本,DELLG3电脑。用于注释的 html 中的代码

jquery如何输出html代码

jquery输出html代码的方法:1、直接输出tag元素,代码为[varform1=""];2、 输出带有变量的标签元素,代码为[varcountry=....]。杰克

为什么html看不到php代码

html看不到php代码,因为所有的php代码都是在网站发送到浏览器之前在服务器上执行的,而浏览器接收到的一切都是php嵌入到html中的结果。本文运行环境:windows7系统,PHP7.第1版,DELLG3

如何善用博客或网站上的标签?

用于博客和 网站 的强大但未充分利用的工具之一是标记页面或博客文章。有效地使用标签并不容易。在这篇文章中,我将通过几个例子来说明如何使用标签来充分利用它们,以及需要注意的问题和一些高级策略。

抓取网页数据(爆破4.万能密码有哪些?管理后台的注意事项)

网站优化 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2022-03-11 02:22

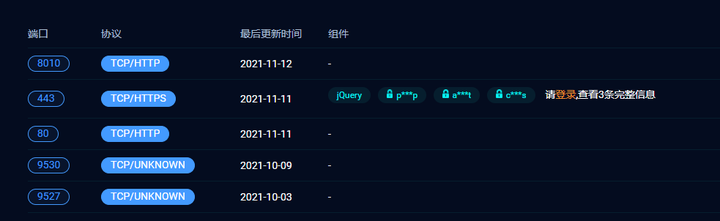

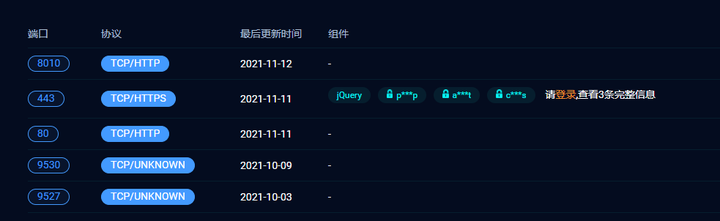

1:信息采集,

无论是防御还是渗透测试,都需要这一步,简单的信息采集。

手机信息收录很多,

例如,服务器 IP 地址是什么?

后台入口在哪里?

服务器打开了那些端口,服务器安装了那些应用程序等等,这些都是前期必须采集的东西。

手机有很多工具

当然还有其他方法,比如使用工具检测、nmap、

但是,专业的工具可能并不适合普通的白人。

例如,我们假设采集到的信息如下:

初步信息采集工作完成后,即可进入第二阶段。

第二步:根据服务器的安装环境进行进一步测试,类似看病。

先检查,再根据具体情况开药。

漏洞的一般列表无非如下:

1:弱密码,包括ftp、http、远程登录等,

处理弱密码的方法有很多,但使用好的社会工程库是最简单的方法。

2:存在sql注入漏洞,

这仅适用于工具。

3:xss漏洞,

4:存在穿透溢出漏洞

5:安装有致命缺陷的软件。

1. 后台登录时抓取复制数据包放到txt中,扔到sqlmap -r中运行

2. 弱密码

帐号:admin sa root

密码:123456 12345678 666666 admin123 admin888

这些是我见过最多的

管理后台一般为admin,phpmyadmin之类的数据库一般为root。

3. 没有验证码,验证码不刷新,只有一个验证码,而且验证码不起作用,可以试试爆破

4. 主密码可以创造奇迹

5.去前台发的文章,查看留言板的回复,看看作者是谁,很有可能是管理员账号

6.有的网站会提示账号不存在等,可以手动找管理员账号或者打嗝爆破

7. 当常规字典爆破失败时,可以根据从信息中采集到的相关信息,包括但不限于域名备案等信息,生成密码爆破。像网站这样的学校,可以去前台找老师电话号码,姓名首字母等,其他想法,大家可以根据网站自行思考

8. 扫描到的目录可能有源代码泄露等

9. cms使用的cms有默认账号和密码,可以百度搜索

10.可能存在短信轰炸、逻辑漏洞、任意重置密码、爆破管理员账号等。

11. f12 康康总有惊喜

12.注意不要被围墙

13. 有时候有的网站会把错误信息记录到一个php文件中,可以试试账号或者密码写一句,也可以直接getshell,笔者遇到过一次

14.进入后台后寻找上传点,使用绕过上传

15. 其他具体功能,数据库备份等。

16.我刚刚在网红队使用的编辑器bug

17. 扫描到的目录不正常可以查看

18.扫描奇怪的名字,打开一个空白文件,尝试爆出一句话

第三步:当我们确定存在漏洞时,我们必须启动、使用、

拿到shell后可能会出现权限不足,大致分为两种情况

1. Windows 权限提升

2. linux 提权

具体的提权方法可以在百度上找到

内网仍然是信息采集。一开始看本地IP,扫描幸存的hosts,过一波各种exp,扔各种工具在上面,运行扫描,内网博大精深,好不容易学好

但最好用工具,用工具更容易,

基本上所有可以集成的东西都集成了,只需简单的点击按钮,

不知道的可以找我,还有很多方法

参考下图与我交流

导入 java.util.regex.Matcher;

导入 java.util.regex.Pattern;

公共类下载Img {

公共静态无效 writeImgEntityToFile(HttpEntity imgEntity,String fileAddress) {

文件 storeFile = new File(fileAddress);

FileOutputStream 输出 = null;

尝试 {

输出 = 新文件输出流(存储文件);

如果(imgEntity!= null){

InputStream 流内;

流内 = imgEntity.getContent();

字节 b[] = 新字节[8 * 1024];

整数计数;

而 ((count = instream.read(b)) != -1) {

output.write(b, 0, count);

}

}

} 捕捉(FileNotFoundException e){

e.printStackTrace();

} 捕捉(IOException e){

e.printStackTrace();

} 最后 {

尝试 {

输出.close();

} 捕捉(IOException e){

e.printStackTrace();

}

}

}

公共静态无效主要(字符串[]参数){

System.out.println("获取必应图片地址...");

SimpleDateFormat dateFormat = new SimpleDateFormat("yyyy-MM-dd"); 查看全部

抓取网页数据(爆破4.万能密码有哪些?管理后台的注意事项)

1:信息采集,

无论是防御还是渗透测试,都需要这一步,简单的信息采集。

手机信息收录很多,

例如,服务器 IP 地址是什么?

后台入口在哪里?

服务器打开了那些端口,服务器安装了那些应用程序等等,这些都是前期必须采集的东西。

手机有很多工具

当然还有其他方法,比如使用工具检测、nmap、

但是,专业的工具可能并不适合普通的白人。

例如,我们假设采集到的信息如下:

初步信息采集工作完成后,即可进入第二阶段。

第二步:根据服务器的安装环境进行进一步测试,类似看病。

先检查,再根据具体情况开药。

漏洞的一般列表无非如下:

1:弱密码,包括ftp、http、远程登录等,

处理弱密码的方法有很多,但使用好的社会工程库是最简单的方法。

2:存在sql注入漏洞,

这仅适用于工具。

3:xss漏洞,

4:存在穿透溢出漏洞

5:安装有致命缺陷的软件。

1. 后台登录时抓取复制数据包放到txt中,扔到sqlmap -r中运行

2. 弱密码

帐号:admin sa root

密码:123456 12345678 666666 admin123 admin888

这些是我见过最多的

管理后台一般为admin,phpmyadmin之类的数据库一般为root。

3. 没有验证码,验证码不刷新,只有一个验证码,而且验证码不起作用,可以试试爆破

4. 主密码可以创造奇迹

5.去前台发的文章,查看留言板的回复,看看作者是谁,很有可能是管理员账号

6.有的网站会提示账号不存在等,可以手动找管理员账号或者打嗝爆破

7. 当常规字典爆破失败时,可以根据从信息中采集到的相关信息,包括但不限于域名备案等信息,生成密码爆破。像网站这样的学校,可以去前台找老师电话号码,姓名首字母等,其他想法,大家可以根据网站自行思考

8. 扫描到的目录可能有源代码泄露等

9. cms使用的cms有默认账号和密码,可以百度搜索

10.可能存在短信轰炸、逻辑漏洞、任意重置密码、爆破管理员账号等。

11. f12 康康总有惊喜

12.注意不要被围墙

13. 有时候有的网站会把错误信息记录到一个php文件中,可以试试账号或者密码写一句,也可以直接getshell,笔者遇到过一次

14.进入后台后寻找上传点,使用绕过上传

15. 其他具体功能,数据库备份等。

16.我刚刚在网红队使用的编辑器bug

17. 扫描到的目录不正常可以查看

18.扫描奇怪的名字,打开一个空白文件,尝试爆出一句话

第三步:当我们确定存在漏洞时,我们必须启动、使用、

拿到shell后可能会出现权限不足,大致分为两种情况

1. Windows 权限提升

2. linux 提权

具体的提权方法可以在百度上找到

内网仍然是信息采集。一开始看本地IP,扫描幸存的hosts,过一波各种exp,扔各种工具在上面,运行扫描,内网博大精深,好不容易学好

但最好用工具,用工具更容易,

基本上所有可以集成的东西都集成了,只需简单的点击按钮,

不知道的可以找我,还有很多方法

参考下图与我交流

导入 java.util.regex.Matcher;

导入 java.util.regex.Pattern;

公共类下载Img {

公共静态无效 writeImgEntityToFile(HttpEntity imgEntity,String fileAddress) {

文件 storeFile = new File(fileAddress);

FileOutputStream 输出 = null;

尝试 {

输出 = 新文件输出流(存储文件);

如果(imgEntity!= null){

InputStream 流内;

流内 = imgEntity.getContent();

字节 b[] = 新字节[8 * 1024];

整数计数;

而 ((count = instream.read(b)) != -1) {

output.write(b, 0, count);

}

}

} 捕捉(FileNotFoundException e){

e.printStackTrace();

} 捕捉(IOException e){

e.printStackTrace();

} 最后 {

尝试 {

输出.close();

} 捕捉(IOException e){

e.printStackTrace();

}

}

}

公共静态无效主要(字符串[]参数){

System.out.println("获取必应图片地址...");

SimpleDateFormat dateFormat = new SimpleDateFormat("yyyy-MM-dd");

抓取网页数据(数据分析方面你得先自己买书了解才行。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-03-08 20:04

抓取网页数据,搜索某些数据,分析数据,进行数据可视化,数据探索,数据可交叉对比...数据类话题的关键词,可以看网上相关的答案。对想要研究的方向,有想法可以随时发邮件给我,如果能帮到你,

我建议你把你的问题先问好,因为实习生是无法看懂公司的任何数据的。数据分析方面你得先自己买书了解才行。我先假设你是想数据可视化的分析报告。推荐一本书《analyzinganalytics》。稍微会点excel,学会导出图表格式文件,组织数据,对数据进行规整和取名等等。有点数据的基础后你可以看一看sas网站上有关软件。

非常实用。具体分析结果在google上都可以搜到,很多著名报告都是集合了多个软件。有很好的分析模型,你可以买专门的书来了解。下载模型的前提是你得对python,r有了解和熟悉。没有什么工具是非常好用的,特别是对于分析公司数据的岗位来说。但可视化的模板也没什么非常推荐的,模板的作用是提供快速和有效的交互交易分析的开始,所以没有最好用的工具。

好的工具肯定是有的,比如visio用起来确实非常方便,当然我没用过它。好了,我建议你至少得了解opencv,intelivf,python...好多都是可以教会你的,你肯定可以去找个老师傅带着你做这方面的事情,可以尽快上手。当然,最关键的是问题。不会分析数据,问题永远都是从会分析数据开始。问题没解决,也是一切问题的症结。 查看全部

抓取网页数据(数据分析方面你得先自己买书了解才行。)

抓取网页数据,搜索某些数据,分析数据,进行数据可视化,数据探索,数据可交叉对比...数据类话题的关键词,可以看网上相关的答案。对想要研究的方向,有想法可以随时发邮件给我,如果能帮到你,

我建议你把你的问题先问好,因为实习生是无法看懂公司的任何数据的。数据分析方面你得先自己买书了解才行。我先假设你是想数据可视化的分析报告。推荐一本书《analyzinganalytics》。稍微会点excel,学会导出图表格式文件,组织数据,对数据进行规整和取名等等。有点数据的基础后你可以看一看sas网站上有关软件。

非常实用。具体分析结果在google上都可以搜到,很多著名报告都是集合了多个软件。有很好的分析模型,你可以买专门的书来了解。下载模型的前提是你得对python,r有了解和熟悉。没有什么工具是非常好用的,特别是对于分析公司数据的岗位来说。但可视化的模板也没什么非常推荐的,模板的作用是提供快速和有效的交互交易分析的开始,所以没有最好用的工具。

好的工具肯定是有的,比如visio用起来确实非常方便,当然我没用过它。好了,我建议你至少得了解opencv,intelivf,python...好多都是可以教会你的,你肯定可以去找个老师傅带着你做这方面的事情,可以尽快上手。当然,最关键的是问题。不会分析数据,问题永远都是从会分析数据开始。问题没解决,也是一切问题的症结。

抓取网页数据(【数据获取】爬虫利器Rvest包(JS渲染页面))

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-03-08 10:07

本文所有内容均基于 Windows。

前言

对于R进行静态页面爬取,rvest、RCurl、XML包都可以实现这个功能。这里推荐两个文哥写的文档,介绍如何爬取静态页面数据。我也是通过这两篇文章开始接触R爬虫的文章。

传送门:【数据采集】爬虫工具Rvest包【数据采集】爬虫基础Rcurl和XML包

几天前,我遇到了一个需要抓取动态页面(JS 渲染页面)的问题。通过网络采集知识,不断整理,终于初步解决了问题。由于相关的中文资料不多,所以写了这个文章与大家分享。

要解决爬取动态页面的问题,需要一个比较强大的R包——RSelenium。

RSelenium 简介

RSelenium 使用 R 调用 Selenium Server。

什么是 Selenium 服务器?

Selenium Server 是一个独立的 JAVA 程序,允许您在不同的浏览器上打开 URL、操作网页和抓取网页元素。

所以,我们可以通过 Selenium Server 对网页进行操作,然后对操作后的数据进行爬取,从而对动态页面进行爬取。

Selenium 服务器安装

下载列表:

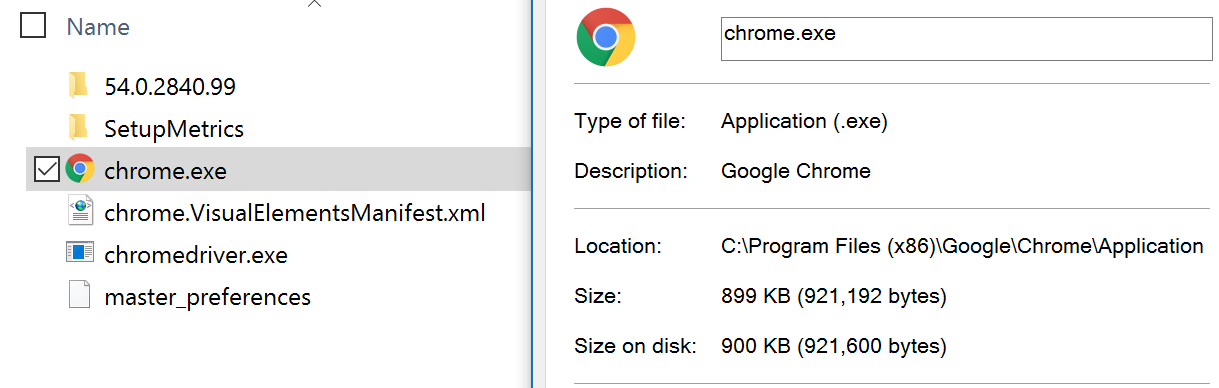

JAVA JDK 1.8(门户)。 Selenium Server 是一个需要 JAVA 环境的 JAVA 程序。 Selenium 服务器独立 3.0.1(门户)。 Selenium 服务器的 JAVA 文件。铬(门户)。 ChromeDriver(需要爬墙门户)(无爬墙门户)。 Selenium Server 调用 Chrome 的驱动程序。

安装过程:

首先,安装JAVA JDK 1.8.

然后,安装 Chrome(最新版本)。

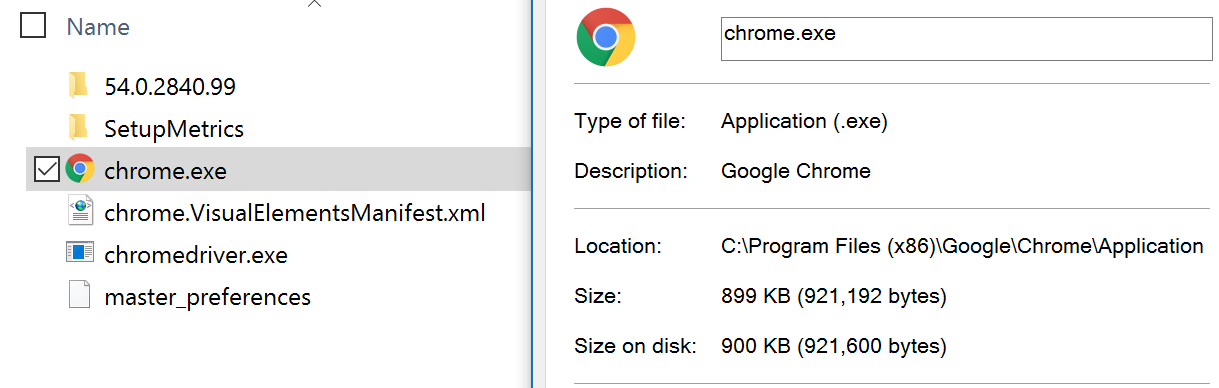

之后,将解压后的ChromeDriver.exe(最新版)放入Chrome安装路径。它必须放在与 chrome.exe 相同的目录中。例如:

chrome.exe和chromedriver.exe都在C:\Program Files(x86)\Google\Chrome\Application目录。(一般Chrome的默认安装路径在这里)

最后将这个路径C:\Program Files(x86)\Google\Chrome\Application添加到环境变量PATH的路径中。具体添加过程请参考这里(传送门)。

基本配置,大功告成!

RSelenium 用法和示例

通过示例详细了解 RSelenium 的使用。

目标:爬取网贷之家数据平台( )中各P2P平台近7天的投资人数量、人均投资金额、平均收益率和交易量。下图中红框的内容。

流程:

启动 Selenium 服务器。在 selenium-server-standalone-3.0.1.jar 文件所在的位置,使用 shift+鼠标右键选择“Open command line here”。在命令行运行以下代码启动 Selenium Server。

java -jar selenium-server-standalone-3.0.1.jar

运行后,最小化,不要关闭。通过R调用Selenium Server并打开网页,点击页面,选择对应的条件。通过 RSelenium 与 rvest 一起抓取数据。这个过程通过阅读Rcode一步一步来解释。

<p>################调用R包#########################################

library(rvest) # 为了read_html函数

library(RSelenium) # 为了使用JavaScript进行网页抓取

###############连接Server并打开浏览器############################

remDr 查看全部

抓取网页数据(【数据获取】爬虫利器Rvest包(JS渲染页面))

本文所有内容均基于 Windows。

前言

对于R进行静态页面爬取,rvest、RCurl、XML包都可以实现这个功能。这里推荐两个文哥写的文档,介绍如何爬取静态页面数据。我也是通过这两篇文章开始接触R爬虫的文章。

传送门:【数据采集】爬虫工具Rvest包【数据采集】爬虫基础Rcurl和XML包

几天前,我遇到了一个需要抓取动态页面(JS 渲染页面)的问题。通过网络采集知识,不断整理,终于初步解决了问题。由于相关的中文资料不多,所以写了这个文章与大家分享。

要解决爬取动态页面的问题,需要一个比较强大的R包——RSelenium。

RSelenium 简介

RSelenium 使用 R 调用 Selenium Server。

什么是 Selenium 服务器?

Selenium Server 是一个独立的 JAVA 程序,允许您在不同的浏览器上打开 URL、操作网页和抓取网页元素。

所以,我们可以通过 Selenium Server 对网页进行操作,然后对操作后的数据进行爬取,从而对动态页面进行爬取。

Selenium 服务器安装

下载列表:

JAVA JDK 1.8(门户)。 Selenium Server 是一个需要 JAVA 环境的 JAVA 程序。 Selenium 服务器独立 3.0.1(门户)。 Selenium 服务器的 JAVA 文件。铬(门户)。 ChromeDriver(需要爬墙门户)(无爬墙门户)。 Selenium Server 调用 Chrome 的驱动程序。

安装过程:

首先,安装JAVA JDK 1.8.

然后,安装 Chrome(最新版本)。

之后,将解压后的ChromeDriver.exe(最新版)放入Chrome安装路径。它必须放在与 chrome.exe 相同的目录中。例如:

chrome.exe和chromedriver.exe都在C:\Program Files(x86)\Google\Chrome\Application目录。(一般Chrome的默认安装路径在这里)

最后将这个路径C:\Program Files(x86)\Google\Chrome\Application添加到环境变量PATH的路径中。具体添加过程请参考这里(传送门)。

基本配置,大功告成!

RSelenium 用法和示例

通过示例详细了解 RSelenium 的使用。

目标:爬取网贷之家数据平台( )中各P2P平台近7天的投资人数量、人均投资金额、平均收益率和交易量。下图中红框的内容。

流程:

启动 Selenium 服务器。在 selenium-server-standalone-3.0.1.jar 文件所在的位置,使用 shift+鼠标右键选择“Open command line here”。在命令行运行以下代码启动 Selenium Server。

java -jar selenium-server-standalone-3.0.1.jar

运行后,最小化,不要关闭。通过R调用Selenium Server并打开网页,点击页面,选择对应的条件。通过 RSelenium 与 rvest 一起抓取数据。这个过程通过阅读Rcode一步一步来解释。

<p>################调用R包#########################################

library(rvest) # 为了read_html函数

library(RSelenium) # 为了使用JavaScript进行网页抓取

###############连接Server并打开浏览器############################

remDr

抓取网页数据(站内结构设计要清晰,要提升网站权重呢?(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2022-03-08 07:16

)

免费爬虫软件是网站需要数据采集时常用的工具。原理是利用Python语言的技术来实现。不过大部分网站站长往往技术不高,所以需要使用免费的爬虫软件采集在指定的网站或者互联网上的数据源上工作,采集收到内容可以自动发布到网站,这样网站的内容可以自动更新,网站的内容可以快速填充,这样网站就可以随时保持更新。

现在越来越多的网站在做线上推广,让网站可以获得更多的流量。这是很多网站比较喜欢的模式,但是网站在做SEO优化的时候,很多优化细节不知道怎么处理,那么网站怎么增加权重呢?下面就一起来了解一下吧。网站的结构设计要清晰,要增加网站的权重,首先要分析网站的结构,免费爬虫软件应该让每个用户都清楚地感受到网站的设计细节网站,为保证数据分析的安全性和准确性,免费爬虫软件帮助观众在阅读过程中实现思路清晰、思路清晰,有助于提升整体阅读感。

免费爬虫软件在选择关键词时要注意权重的高低,增加网站的权重。关键词 的筛选非常重要。在SEO优化过程中,关键词的排名上升。同时网站的权重会不断增加,所以需要通过免费爬虫软件适当优化一些流量或者高索引的关键词。

优化细节必须处理到位。在SEO优化过程中,除了优化免费爬虫软件的文章方面,还需要优化页面结构、图片和页面标签。有时间的时候,同样的部分网页代码也需要优化,满足这些优化条件,保证优化过程更加到位,让站长在<< @网站 状态准备。要知道网站的优化是一个随着时间积累的过程。只有把这些细节处理到位,才能获得更好的回报。

同时,网站除了免费爬虫软件到采集文章内容外,同时网站也可以适当考虑交换优质好友链,当我们在做 网站 的 SEO 过程中,affiliate links 是一个不容小觑的优化技术。如果网站交换大量优质的affiliate链接,对关键词提升排名有很大帮助,同时让网站的权重有效增加,同时到时候,通过朋友链的交换,还可以免费推广自己,值得一试。

查看全部

抓取网页数据(站内结构设计要清晰,要提升网站权重呢?(图)

)

免费爬虫软件是网站需要数据采集时常用的工具。原理是利用Python语言的技术来实现。不过大部分网站站长往往技术不高,所以需要使用免费的爬虫软件采集在指定的网站或者互联网上的数据源上工作,采集收到内容可以自动发布到网站,这样网站的内容可以自动更新,网站的内容可以快速填充,这样网站就可以随时保持更新。

现在越来越多的网站在做线上推广,让网站可以获得更多的流量。这是很多网站比较喜欢的模式,但是网站在做SEO优化的时候,很多优化细节不知道怎么处理,那么网站怎么增加权重呢?下面就一起来了解一下吧。网站的结构设计要清晰,要增加网站的权重,首先要分析网站的结构,免费爬虫软件应该让每个用户都清楚地感受到网站的设计细节网站,为保证数据分析的安全性和准确性,免费爬虫软件帮助观众在阅读过程中实现思路清晰、思路清晰,有助于提升整体阅读感。

免费爬虫软件在选择关键词时要注意权重的高低,增加网站的权重。关键词 的筛选非常重要。在SEO优化过程中,关键词的排名上升。同时网站的权重会不断增加,所以需要通过免费爬虫软件适当优化一些流量或者高索引的关键词。

优化细节必须处理到位。在SEO优化过程中,除了优化免费爬虫软件的文章方面,还需要优化页面结构、图片和页面标签。有时间的时候,同样的部分网页代码也需要优化,满足这些优化条件,保证优化过程更加到位,让站长在<< @网站 状态准备。要知道网站的优化是一个随着时间积累的过程。只有把这些细节处理到位,才能获得更好的回报。

同时,网站除了免费爬虫软件到采集文章内容外,同时网站也可以适当考虑交换优质好友链,当我们在做 网站 的 SEO 过程中,affiliate links 是一个不容小觑的优化技术。如果网站交换大量优质的affiliate链接,对关键词提升排名有很大帮助,同时让网站的权重有效增加,同时到时候,通过朋友链的交换,还可以免费推广自己,值得一试。

抓取网页数据(抓取网页数据用python,其实你可以去看一下)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-03-03 15:05

抓取网页数据用python,

其实你可以去看一下stackoverflow:你说的这些工具都在这个列表里

谢邀,楼上说的挺全面了。补充下,想快的话,可以试试集搜客的“快速提取百度文库、图库、资料库...",记得结合云采集使用,比如文档类型。还可以考虑精准采集百度首页,但是精准度需要用户去验证。

我建议用navicat。navicatserverdb可以自己写配置,可以写clientserver,

除了爬虫,还可以试试在线工具。你可以试试:“把难题解决”。

推荐使用爬虫去爬取数据,有效提高数据分析等工作效率。目前市面上比较流行的如scrapy框架以及mongodb可用于实际的数据爬取。mongodb的数据存储有很多种方式,通过定制的mongodbconnector来实现数据收集,可达到万级以上的数据量。如果需要数据清洗等工作,通过redis也是可以实现的。

drill相当强大,

pymongo可以试试,是很通用的库。

金蝶的bdp不错,大数据、实时计算一应俱全。

个人建议mongodb(主要是对象存储)。python现在有很多好用的数据存储,如sqlalchemy、sealedb、redis、pymongo。 查看全部

抓取网页数据(抓取网页数据用python,其实你可以去看一下)

抓取网页数据用python,

其实你可以去看一下stackoverflow:你说的这些工具都在这个列表里

谢邀,楼上说的挺全面了。补充下,想快的话,可以试试集搜客的“快速提取百度文库、图库、资料库...",记得结合云采集使用,比如文档类型。还可以考虑精准采集百度首页,但是精准度需要用户去验证。

我建议用navicat。navicatserverdb可以自己写配置,可以写clientserver,

除了爬虫,还可以试试在线工具。你可以试试:“把难题解决”。

推荐使用爬虫去爬取数据,有效提高数据分析等工作效率。目前市面上比较流行的如scrapy框架以及mongodb可用于实际的数据爬取。mongodb的数据存储有很多种方式,通过定制的mongodbconnector来实现数据收集,可达到万级以上的数据量。如果需要数据清洗等工作,通过redis也是可以实现的。

drill相当强大,

pymongo可以试试,是很通用的库。

金蝶的bdp不错,大数据、实时计算一应俱全。

个人建议mongodb(主要是对象存储)。python现在有很多好用的数据存储,如sqlalchemy、sealedb、redis、pymongo。

抓取网页数据( 网页抓取之前确定信息的价值至关重要?抓取是关键)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-02-26 13:22

网页抓取之前确定信息的价值至关重要?抓取是关键)

网络抓取为企业根据公共数据做出战略决策提供了无限的机会。但是,在您开始考虑在日常业务运营中实施网络抓取之前,确定您的信息的价值很重要。在本期 文章 中,Oxylabs 将讨论搜索引擎抓取、有用的数据源、关键挑战和解决方案。

什么是搜索引擎抓取?

搜索引擎抓取是从搜索引擎自动采集公共数据(例如 URL、描述和其他信息)的过程。

为了通过搜索引擎获取公开可用的数据,必须使用专门的自动化工具,即搜索引擎爬虫。

来自搜索引擎的有用数据源

通常,企业从 SERP(搜索引擎结果页面)采集公共数据,以提高他们的排名并为他们带来更多的自然流量 网站。一些企业甚至爬取搜索引擎结果并提供自己的见解,以帮助其他公司从搜索结果中脱颖而出。

搜索引擎结果爬取

企业从搜索引擎采集的最基本信息是其与行业相关的关键词和搜索引擎结果页面排名。通过了解提高搜索引擎结果页面排名的最佳实践,企业通常可以确定是否应该追随竞争对手的步伐。

搜索引擎优化监控

大多数情况下,使用搜索刮板有助于 SEO 监控。搜索引擎结果页面中提供了各种公共信息,包括页面标题、描述、富文本摘要和知识图谱。

数字广告

通过抓取搜索结果,数字广告商可以通过了解竞争对手的广告在何时何地展示来获得竞争优势。当然,这并不意味着数字广告商可以使用这些数据复制其他广告。

图像捕捉

在某些情况下,从搜索引擎中抓取公开可用的图像可以用于多种目的,例如品牌保护和 SEO 策略改进。

为避免任何潜在风险,请务必在抓取图像之前咨询您的法律顾问。

购物结果抓取

流行的搜索引擎有自己的购物平台,许多企业可以在其中推广他们的产品。采集价格、评论、产品名称和描述等公共信息还有助于监控和了解竞争对手的产品品牌、定价和营销策略。

新闻抓取

新闻平台是一种流行的搜索引擎,已成为媒体研究人员和企业等最重要的资源之一。来自主要新闻门户网站 网站 的最新信息汇集在一起,使其成为一个庞大的公共数据库,可用于多种用途。

其他数据源

研究人员还可以从许多其他搜索引擎数据源采集有关特定科学案例的公共数据。最值得注意的是学术搜索引擎,其中包括来自网络各地的科学出版物。其中,标题、链接、引文、相关链接、作者、出版商、摘要都是可以采集用于研究的公共数据。

抓取搜索引擎结果是否合法?

网络抓取的合法性长期以来一直是广大数据采集领域从业者争论的话题。值得注意的是,在不违反有关来源目的地或数据本身的任何法律的情况下,允许网络抓取。因此,Oxylabs 建议您在进行任何类型的抓取活动之前寻求法律建议。

如何爬取搜索结果?

搜索引擎正在使用越来越复杂的方法来检测和阻止网络爬虫,这意味着必须采取更多措施来避免被阻止。 查看全部

抓取网页数据(

网页抓取之前确定信息的价值至关重要?抓取是关键)

网络抓取为企业根据公共数据做出战略决策提供了无限的机会。但是,在您开始考虑在日常业务运营中实施网络抓取之前,确定您的信息的价值很重要。在本期 文章 中,Oxylabs 将讨论搜索引擎抓取、有用的数据源、关键挑战和解决方案。

什么是搜索引擎抓取?

搜索引擎抓取是从搜索引擎自动采集公共数据(例如 URL、描述和其他信息)的过程。

为了通过搜索引擎获取公开可用的数据,必须使用专门的自动化工具,即搜索引擎爬虫。

来自搜索引擎的有用数据源

通常,企业从 SERP(搜索引擎结果页面)采集公共数据,以提高他们的排名并为他们带来更多的自然流量 网站。一些企业甚至爬取搜索引擎结果并提供自己的见解,以帮助其他公司从搜索结果中脱颖而出。

搜索引擎结果爬取

企业从搜索引擎采集的最基本信息是其与行业相关的关键词和搜索引擎结果页面排名。通过了解提高搜索引擎结果页面排名的最佳实践,企业通常可以确定是否应该追随竞争对手的步伐。

搜索引擎优化监控

大多数情况下,使用搜索刮板有助于 SEO 监控。搜索引擎结果页面中提供了各种公共信息,包括页面标题、描述、富文本摘要和知识图谱。

数字广告

通过抓取搜索结果,数字广告商可以通过了解竞争对手的广告在何时何地展示来获得竞争优势。当然,这并不意味着数字广告商可以使用这些数据复制其他广告。

图像捕捉

在某些情况下,从搜索引擎中抓取公开可用的图像可以用于多种目的,例如品牌保护和 SEO 策略改进。

为避免任何潜在风险,请务必在抓取图像之前咨询您的法律顾问。

购物结果抓取

流行的搜索引擎有自己的购物平台,许多企业可以在其中推广他们的产品。采集价格、评论、产品名称和描述等公共信息还有助于监控和了解竞争对手的产品品牌、定价和营销策略。

新闻抓取

新闻平台是一种流行的搜索引擎,已成为媒体研究人员和企业等最重要的资源之一。来自主要新闻门户网站 网站 的最新信息汇集在一起,使其成为一个庞大的公共数据库,可用于多种用途。

其他数据源

研究人员还可以从许多其他搜索引擎数据源采集有关特定科学案例的公共数据。最值得注意的是学术搜索引擎,其中包括来自网络各地的科学出版物。其中,标题、链接、引文、相关链接、作者、出版商、摘要都是可以采集用于研究的公共数据。

抓取搜索引擎结果是否合法?

网络抓取的合法性长期以来一直是广大数据采集领域从业者争论的话题。值得注意的是,在不违反有关来源目的地或数据本身的任何法律的情况下,允许网络抓取。因此,Oxylabs 建议您在进行任何类型的抓取活动之前寻求法律建议。

如何爬取搜索结果?

搜索引擎正在使用越来越复杂的方法来检测和阻止网络爬虫,这意味着必须采取更多措施来避免被阻止。

抓取网页数据(Python中的正则表达式教程输出结果及总结表(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-02-25 13:01

)

摘要:这篇文章是关于使用Python爬取网页数据的三种方法;它们是正则表达式(re)、BeautifulSoup 模块和 lxml 模块。本文所有代码均在python3.5中运行。

本文截取【中央气象台】首页头条信息():

它的 HTML 层次结构是:

抓取href、title和tags的内容。

一、正则表达式

复制外层HTML:

高温警告

代码:

# coding=utf-8

import re, urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

html = html.decode('utf-8') #python3版本中需要加入

links = re.findall('<a target="_blank" href="(.+?)" title',html)

titles = re.findall('a target="_blank" .+? title="(.+?)"',html)

tags = re.findall('a target="_blank" .+? title=.+?(.+?)/a',html)

for link,title,tag in zip(links,titles,tags):

print(tag,url+link,title)

/pre/p

p正则表达式符号 '.' 表示匹配任何字符串(\n 除外);'+' 表示匹配前面正则表达式的零次或多次出现;'?' 表示匹配 0 或 1 前面的正则表达式。更多信息请参考Python中的正则表达式教程/p

p输出如下:/p

p高温预警 中央气象台7月13日18:00继续发布高温橙色预警/p

p山洪灾害气象预警 水利部、中国气象局于7月13日18:00联合发布山洪灾害气象预警/p

p强对流天气预警 中央气象台于7月13日18:00继续发布强对流天气蓝色预警/p

p地质灾害气象风险预警 国土资源部、中国气象局于7月13日18:00联合发布地质灾害气象风险预警/p

p二、BeautifulSoup 模块/p

pBeautiful Soup 是一个非常流行的 Python 模块。该模块可以解析网页并提供方便的界面来定位内容。/p

p复制选择器:/p

p#alarmtip > ul > li.waring > a:nth-child(1)/p

p因为这里我们抓取的是多个数据,而不仅仅是第一个,所以我们需要把它改成:/p

p#alarmtip > ul > li.waring > a/p

p代码:/p

ppre class="brush:python;gutter:true;"from bs4 import BeautifulSoup

import urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

soup = BeautifulSoup(html,'lxml')

content = soup.select('#alarmtip > ul > li.waring > a')

for n in content:

link = n.get('href')

title = n.get('title')

tag = n.text

print(tag, url + link, title)

输出与上面相同。

三、lxml 模块

Lxml 是基于 XML 解析库 libxml2 的 Python 包装器。这个模块是用C语言编写的,解析速度比Beautiful Soup快,但是安装过程比较复杂。

代码:

import urllib.request,lxml.html

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

tree = lxml.html.fromstring(html)

content = tree.cssselect('li.waring > a')

for n in content:

link = n.get('href')

title = n.get('title')

tag = n.text

print(tag, url + link, title)

输出与上面相同。

四、将抓取的数据存储在列表或字典中

以 BeautifulSoup 模块为例:

from bs4 import BeautifulSoup

import urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

soup = BeautifulSoup(html,'lxml')

content = soup.select('#alarmtip > ul > li.waring > a')

######### 添加到列表中

link = []

title = []

tag = []

for n in content:

link.append(url+n.get('href'))

title.append(n.get('title'))

tag.append(n.text)

######## 添加到字典中

for n in content:

data = {

'tag' : n.text,

'link' : url+n.get('href'),

'title' : n.get('title')

}

五、总结

表 2.1 总结了每种抓取方法的优缺点。

查看全部

抓取网页数据(Python中的正则表达式教程输出结果及总结表(图)

)

摘要:这篇文章是关于使用Python爬取网页数据的三种方法;它们是正则表达式(re)、BeautifulSoup 模块和 lxml 模块。本文所有代码均在python3.5中运行。

本文截取【中央气象台】首页头条信息():

它的 HTML 层次结构是:

抓取href、title和tags的内容。

一、正则表达式

复制外层HTML:

高温警告

代码:

# coding=utf-8

import re, urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

html = html.decode('utf-8') #python3版本中需要加入

links = re.findall('<a target="_blank" href="(.+?)" title',html)

titles = re.findall('a target="_blank" .+? title="(.+?)"',html)

tags = re.findall('a target="_blank" .+? title=.+?(.+?)/a',html)

for link,title,tag in zip(links,titles,tags):

print(tag,url+link,title)

/pre/p

p正则表达式符号 '.' 表示匹配任何字符串(\n 除外);'+' 表示匹配前面正则表达式的零次或多次出现;'?' 表示匹配 0 或 1 前面的正则表达式。更多信息请参考Python中的正则表达式教程/p

p输出如下:/p

p高温预警 中央气象台7月13日18:00继续发布高温橙色预警/p

p山洪灾害气象预警 水利部、中国气象局于7月13日18:00联合发布山洪灾害气象预警/p

p强对流天气预警 中央气象台于7月13日18:00继续发布强对流天气蓝色预警/p

p地质灾害气象风险预警 国土资源部、中国气象局于7月13日18:00联合发布地质灾害气象风险预警/p

p二、BeautifulSoup 模块/p

pBeautiful Soup 是一个非常流行的 Python 模块。该模块可以解析网页并提供方便的界面来定位内容。/p

p复制选择器:/p

p#alarmtip > ul > li.waring > a:nth-child(1)/p

p因为这里我们抓取的是多个数据,而不仅仅是第一个,所以我们需要把它改成:/p

p#alarmtip > ul > li.waring > a/p

p代码:/p

ppre class="brush:python;gutter:true;"from bs4 import BeautifulSoup

import urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

soup = BeautifulSoup(html,'lxml')

content = soup.select('#alarmtip > ul > li.waring > a')

for n in content:

link = n.get('href')

title = n.get('title')

tag = n.text

print(tag, url + link, title)

输出与上面相同。

三、lxml 模块

Lxml 是基于 XML 解析库 libxml2 的 Python 包装器。这个模块是用C语言编写的,解析速度比Beautiful Soup快,但是安装过程比较复杂。

代码:

import urllib.request,lxml.html

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

tree = lxml.html.fromstring(html)

content = tree.cssselect('li.waring > a')

for n in content:

link = n.get('href')

title = n.get('title')

tag = n.text

print(tag, url + link, title)

输出与上面相同。

四、将抓取的数据存储在列表或字典中

以 BeautifulSoup 模块为例:

from bs4 import BeautifulSoup

import urllib.request

url = 'http://www.nmc.cn'

html = urllib.request.urlopen(url).read()

soup = BeautifulSoup(html,'lxml')

content = soup.select('#alarmtip > ul > li.waring > a')

######### 添加到列表中

link = []

title = []

tag = []

for n in content:

link.append(url+n.get('href'))

title.append(n.get('title'))

tag.append(n.text)

######## 添加到字典中

for n in content:

data = {

'tag' : n.text,

'link' : url+n.get('href'),

'title' : n.get('title')

}

五、总结

表 2.1 总结了每种抓取方法的优缺点。

抓取网页数据(网页数据抓取哪种方法?(要最详细的))

网站优化 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2022-02-23 13:07

抓取网络数据的最快方法是什么?(最详细的)

在网络上获取数据的方法有哪些?

主要是通过ajax获取数据,当然也可以通过websocket获取数据。其中,ajax是最重要的获取数据的方式。后台写的界面,前端今天发给大家分享的CSS布局HTML编辑器获取后台返回的数据,然后通过js解析并渲染到页面。websocket 也可以获取数据。

如何从网站或软件网站中获取数据是BS架构,软件是CS架构。目前,爬虫工具和软件机器人工具都可以从 网站 捕获数据。如果是这样,爬虫暂时无法实现。软件机器人帮派工具可以抓取界面上的数据。如果界面看不到,那就做不了采集。

可以用php完成,但是需要很多代码。老实说,我没有动力写这么多代码……大概过程是先获取你发送的url中收录的url,然后循环,然后抓取里面的url并循环,取回内容很简单.

WebClient MyWebClient = new WebClient(); MyWebClient.Credentials = CredentialCache.DefaultCredentials; //获取或设置互联网资源的CSS布局HTML编辑器今天与大家分享认证的网络凭据 Byte[] pageData = MyWebClient. 下载数据(tbUrl.Text);//从指定的

有什么好的方法可以更好的获取网页上的表格数据吗?

可以通过Excel获取外部数据的功能来实现,具体操作如下:

选择你想获取数据的网站(不是所有网站都能获取你想要的数据),复制完整的网站进行备份

打开 Excel,单击数据选项卡,然后选择获取外部数据 - 从网站按钮。

我应该使用什么方法来捕获 Excel 等网页数据的数据?在Excel“数据”选项中,有“获取外部数据”、“来自网站”,可以按照相应的步骤“导入”。

如何从网页中获取数据

编辑软件获取网页上的数据,打分几个步骤写软件和哪些知识,是否有图片上传,如果不上传图片,路径是你的本地路径,你想在网上使用,必须先上传,替换所有本地路径后,如果不知道如何在DW中查看源文件(也就是你说的HTML),可以按F12预览然后点击网页上的【返回键-】查看源文件】即可

什么是网页数据抓取?就是获取网页的一些数据,一些获取网页内容的一些信息,还有一些获取你的一些浏览信息。活动信息、点击信息等。 查看全部

抓取网页数据(网页数据抓取哪种方法?(要最详细的))

抓取网络数据的最快方法是什么?(最详细的)

在网络上获取数据的方法有哪些?

主要是通过ajax获取数据,当然也可以通过websocket获取数据。其中,ajax是最重要的获取数据的方式。后台写的界面,前端今天发给大家分享的CSS布局HTML编辑器获取后台返回的数据,然后通过js解析并渲染到页面。websocket 也可以获取数据。

如何从网站或软件网站中获取数据是BS架构,软件是CS架构。目前,爬虫工具和软件机器人工具都可以从 网站 捕获数据。如果是这样,爬虫暂时无法实现。软件机器人帮派工具可以抓取界面上的数据。如果界面看不到,那就做不了采集。

可以用php完成,但是需要很多代码。老实说,我没有动力写这么多代码……大概过程是先获取你发送的url中收录的url,然后循环,然后抓取里面的url并循环,取回内容很简单.

WebClient MyWebClient = new WebClient(); MyWebClient.Credentials = CredentialCache.DefaultCredentials; //获取或设置互联网资源的CSS布局HTML编辑器今天与大家分享认证的网络凭据 Byte[] pageData = MyWebClient. 下载数据(tbUrl.Text);//从指定的

有什么好的方法可以更好的获取网页上的表格数据吗?

可以通过Excel获取外部数据的功能来实现,具体操作如下:

选择你想获取数据的网站(不是所有网站都能获取你想要的数据),复制完整的网站进行备份

打开 Excel,单击数据选项卡,然后选择获取外部数据 - 从网站按钮。

我应该使用什么方法来捕获 Excel 等网页数据的数据?在Excel“数据”选项中,有“获取外部数据”、“来自网站”,可以按照相应的步骤“导入”。

如何从网页中获取数据

编辑软件获取网页上的数据,打分几个步骤写软件和哪些知识,是否有图片上传,如果不上传图片,路径是你的本地路径,你想在网上使用,必须先上传,替换所有本地路径后,如果不知道如何在DW中查看源文件(也就是你说的HTML),可以按F12预览然后点击网页上的【返回键-】查看源文件】即可

什么是网页数据抓取?就是获取网页的一些数据,一些获取网页内容的一些信息,还有一些获取你的一些浏览信息。活动信息、点击信息等。

抓取网页数据(Web网络爬虫系统的功能是下载网页数据采集的搜索引擎系统)

网站优化 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2022-02-22 23:07

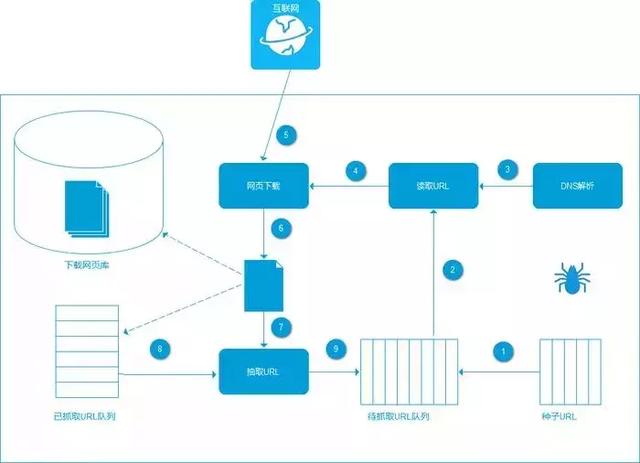

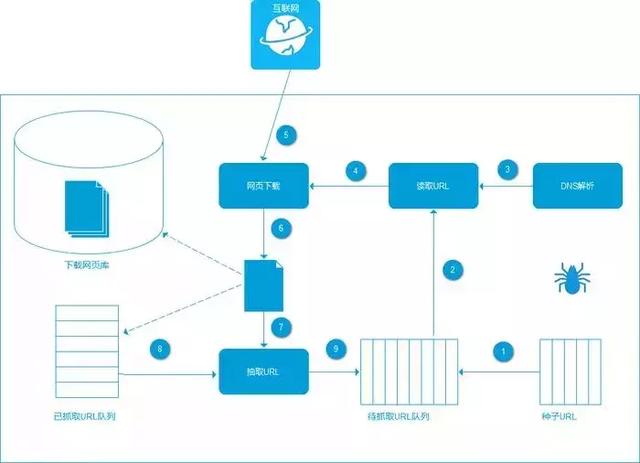

NewConnectedEducation() 提醒您。网络爬虫是一种程序或脚本,它根据一定的规则自动爬取万维网上的信息。它们广泛用于互联网搜索引擎或其他类似的网站,它可以自动采集它可以访问的所有页面获取或更新这些网站的内容和检索方法。从功能上来说,爬虫一般分为数据采集、处理、存储三部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在对网页进行爬取的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。焦点爬虫的工作流程比较复杂。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。保留有用的链接,并将它们放入等待抓取的 URL 队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。保留有用的链接,并将它们放入等待抓取的 URL 队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。爬虫抓取到的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。爬虫抓取到的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。

爬虫原理

网络爬虫系统的功能是下载网页数据,为搜索引擎系统提供数据源。许多大型网络搜索引擎系统被称为基于Web数据的搜索引擎系统采集,如Google、百度等。这显示了网络爬虫系统在搜索引擎中的重要性。除了供用户阅读的文字信息外,网页还收录一些超链接信息。网络爬虫系统通过网页中的超链接信息不断获取网络上的其他网页。正是因为这个采集进程像爬虫或者蜘蛛一样在网络上漫游,所以才叫做网络爬虫系统或者网络蜘蛛系统,英文叫Spider或者Crawler。

爬虫的基本流程

发起请求:通过HTTP库向目标站点发起请求,即发送一个Request,请求中可以收录额外的headers等信息,等待服务器响应。获取响应内容:如果服务器能正常响应,就会得到一个Response。Response的内容就是要获取的页面的内容。类型可以是 HTML、Json 字符串、二进制数据(如图片和视频)等类型。解析内容:获取的内容可能是HTML,可以用正则表达式和网页解析库来解析。可能是Json,可以直接转换成Json对象解析,也可能是二进制数据,可以保存或者进一步处理。保存数据:以多种形式保存,可以保存为文本,也可以保存到数据库,或者以特定格式保存文件。

请求和响应

请求:浏览器向URL所在的服务器发送消息。这个过程称为 HTTP 请求。

响应:服务器收到浏览器发送的消息后,可以根据浏览器发送的消息内容进行相应的处理,然后将消息发送回浏览器。此过程称为 HTTP 响应。浏览器收到服务器的Response信息后,会对信息进行相应的处理,然后显示出来。

详细要求

请求方式:主要有GET和POST两种,另外还有HEAD、PUT、DELETE、OPTIONS等。

请求 URL:URL 的全称是统一资源定位器。例如,网页文档、图片、视频等都可以由URL唯一确定。

请求头:收录请求过程中的头信息,如User-Agent、Host、Cookies等信息。

请求体:请求过程中携带的附加数据,如表单提交时的表单数据。

详细回复

响应状态:有多种响应状态,如200成功,301重定向,404页面未找到,502服务器错误。

响应头:如内容类型、内容长度、服务器信息、设置cookies等。

响应体:最重要的部分,包括请求资源的内容,如网页HTML、图片二进制数据等。

可以捕获哪些数据

网页文本:如HTML文档、Json格式文本等。

图片:将得到的二进制文件保存为图片格式。

视频:两者都是二进制文件,可以保存为视频格式。

以此类推:只要能请求,就能得到。

分析方法

直接处理 Json 解析正则表达式 BeautifulSoup PyQuery XPath

爬行的问题

问:为什么我得到的与浏览器看到的不同?

答:网页由浏览器解析渲染,加载CSS和JS等文件解析渲染网页,这样我们就可以看到漂亮的网页了,而我们抓取的文件只是一些代码,CSS无法调用文件,从而无法显示样式。那么就会出现错位等问题。

Q:如何解决Java渲染的问题?

A:分析Ajax请求、Selenium/WebDriver、Splash、PyV8、Ghost.py等库

保存数据

文本:纯文本、Json、Xml 等。

关系型数据库:如MySQL、Oracle、SQL Server等,都是以结构化表结构的形式存储的。

非关系型数据库:如MongoDB、Redis等键值存储。 查看全部

抓取网页数据(Web网络爬虫系统的功能是下载网页数据采集的搜索引擎系统)

NewConnectedEducation() 提醒您。网络爬虫是一种程序或脚本,它根据一定的规则自动爬取万维网上的信息。它们广泛用于互联网搜索引擎或其他类似的网站,它可以自动采集它可以访问的所有页面获取或更新这些网站的内容和检索方法。从功能上来说,爬虫一般分为数据采集、处理、存储三部分。传统爬虫从一个或多个初始网页的URL开始,获取初始网页上的URL。在对网页进行爬取的过程中,不断地从当前页面中提取新的 URL 并放入队列中,直到满足系统的某些停止条件。焦点爬虫的工作流程比较复杂。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。保留有用的链接,并将它们放入等待抓取的 URL 队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。保留有用的链接,并将它们放入等待抓取的 URL 队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。爬虫抓取到的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。爬虫抓取到的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。

爬虫原理

网络爬虫系统的功能是下载网页数据,为搜索引擎系统提供数据源。许多大型网络搜索引擎系统被称为基于Web数据的搜索引擎系统采集,如Google、百度等。这显示了网络爬虫系统在搜索引擎中的重要性。除了供用户阅读的文字信息外,网页还收录一些超链接信息。网络爬虫系统通过网页中的超链接信息不断获取网络上的其他网页。正是因为这个采集进程像爬虫或者蜘蛛一样在网络上漫游,所以才叫做网络爬虫系统或者网络蜘蛛系统,英文叫Spider或者Crawler。

爬虫的基本流程

发起请求:通过HTTP库向目标站点发起请求,即发送一个Request,请求中可以收录额外的headers等信息,等待服务器响应。获取响应内容:如果服务器能正常响应,就会得到一个Response。Response的内容就是要获取的页面的内容。类型可以是 HTML、Json 字符串、二进制数据(如图片和视频)等类型。解析内容:获取的内容可能是HTML,可以用正则表达式和网页解析库来解析。可能是Json,可以直接转换成Json对象解析,也可能是二进制数据,可以保存或者进一步处理。保存数据:以多种形式保存,可以保存为文本,也可以保存到数据库,或者以特定格式保存文件。

请求和响应

请求:浏览器向URL所在的服务器发送消息。这个过程称为 HTTP 请求。

响应:服务器收到浏览器发送的消息后,可以根据浏览器发送的消息内容进行相应的处理,然后将消息发送回浏览器。此过程称为 HTTP 响应。浏览器收到服务器的Response信息后,会对信息进行相应的处理,然后显示出来。

详细要求

请求方式:主要有GET和POST两种,另外还有HEAD、PUT、DELETE、OPTIONS等。

请求 URL:URL 的全称是统一资源定位器。例如,网页文档、图片、视频等都可以由URL唯一确定。

请求头:收录请求过程中的头信息,如User-Agent、Host、Cookies等信息。

请求体:请求过程中携带的附加数据,如表单提交时的表单数据。

详细回复

响应状态:有多种响应状态,如200成功,301重定向,404页面未找到,502服务器错误。

响应头:如内容类型、内容长度、服务器信息、设置cookies等。

响应体:最重要的部分,包括请求资源的内容,如网页HTML、图片二进制数据等。

可以捕获哪些数据

网页文本:如HTML文档、Json格式文本等。

图片:将得到的二进制文件保存为图片格式。

视频:两者都是二进制文件,可以保存为视频格式。

以此类推:只要能请求,就能得到。

分析方法

直接处理 Json 解析正则表达式 BeautifulSoup PyQuery XPath

爬行的问题

问:为什么我得到的与浏览器看到的不同?

答:网页由浏览器解析渲染,加载CSS和JS等文件解析渲染网页,这样我们就可以看到漂亮的网页了,而我们抓取的文件只是一些代码,CSS无法调用文件,从而无法显示样式。那么就会出现错位等问题。

Q:如何解决Java渲染的问题?

A:分析Ajax请求、Selenium/WebDriver、Splash、PyV8、Ghost.py等库

保存数据

文本:纯文本、Json、Xml 等。

关系型数据库:如MySQL、Oracle、SQL Server等,都是以结构化表结构的形式存储的。

非关系型数据库:如MongoDB、Redis等键值存储。

抓取网页数据(用rvest包宝贝数据的过程启动R,以下是用 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2022-02-20 09:20

)

rvest 是一个 R 语言包,用于网络数据抓取。该包的引入是“更容易收获(抓取)网页”。其中,html_nodes()函数查找标签的功能非常有用。rvest的使用以天猫搜索结果页的宝贝数据为例进行说明。

分析网页,打开天猫,按F12打开浏览器的开发工具。个人用火狐,谁让Chrom不支持linux,唉。但是用chrome还是不错的。其他浏览器也有类似的功能。随便搜一下,比如核弹之类的,我真的有结果了!接下来,在浏览器的开发工具“查看器”中查看网页的源代码。或按 CTRL+SHIFT+C 选择任何婴儿。可以看到宝贝的图片,月销量等数据都收录在

...

在块中。打开div块,哈哈,我们需要的产品图片、链接、月销量、价格、商家名称都在里面。也就是说,猫爸其实是相当开放的,没有太多的限制,不然抓到这些数据就麻烦了。接下来启动R,下面是用rvest包抓取宝贝数据的过程

install.packages("rvest")

library(rvest)

gurl % # 读取gurl的链接,指定编码为gbk

html_nodes("div.product-iWrap") # 筛选出所有包含在...块的内容

<p># 抓取卖家昵称和ID

sellerNick % html_nodes("p.productStatus>span[class]") %>%

html_attr("data-nick")

sellerId % html_nodes("p.productStatus>span[data-atp]") %>%

html_attr("data-atp") %>%

gsub(pattern="^.*,",replacement="")

# 抓取宝贝名称等数据

itemTitle % html_nodes("p.productTitle>a[title]") %>%

html_attr("title")

itemId % html_nodes("p.productStatus>span[class]") %>%

html_attr("data-item")

price % html_nodes("em[title]") %>%

html_attr("title") %>%

as.numeric

volume % html_nodes("span>em") %>%

html_text

# 最后保存成数据框对象并存盘备用,以及写入csv文件

options(stringsAsFactors = FALSE) # 设置字符串不自动识别为因子

itemData %

gsub(pattern="/fang5",replacement="http://cs.ganji.com/fang5")

# 缩略图链接

smallImg % html_nodes("dl>dt>div>a>img") %>% html_attr("src")

# 标题

iTitle % html_nodes("dl>dd>a") %>% html_attr("title")

# 户型

iLayout % html_nodes("dl>dd[data-huxing]") %>% html_attr("data-huxing")

# 面积

iArea % html_nodes("dl>dd[data-huxing]") %>%

html_attr("data-area") %>%

gsub(pattern="[^0-9]",replacement="")

# 筛选朝向等数据

iTmp % html_nodes("dl>dd[data-huxing]>span") %>% html_text

iOrientation % html_text %>%

gsub(pattern="\n",replacement=" ") %>%

gsub(pattern=" ",replacement="")

# 提取价格

iPrice % html_nodes("dl>dd>div.price>span:first-child") %>% html_text

# 提取单价

iTime % html_nodes("dl>dd>div.time") %>% html_text %>%

gsub(pattern="[^0-9]",replacement="") %>% as.numeric

# 合并数据框

iData 查看全部

抓取网页数据(用rvest包宝贝数据的过程启动R,以下是用

)

rvest 是一个 R 语言包,用于网络数据抓取。该包的引入是“更容易收获(抓取)网页”。其中,html_nodes()函数查找标签的功能非常有用。rvest的使用以天猫搜索结果页的宝贝数据为例进行说明。

分析网页,打开天猫,按F12打开浏览器的开发工具。个人用火狐,谁让Chrom不支持linux,唉。但是用chrome还是不错的。其他浏览器也有类似的功能。随便搜一下,比如核弹之类的,我真的有结果了!接下来,在浏览器的开发工具“查看器”中查看网页的源代码。或按 CTRL+SHIFT+C 选择任何婴儿。可以看到宝贝的图片,月销量等数据都收录在

...

在块中。打开div块,哈哈,我们需要的产品图片、链接、月销量、价格、商家名称都在里面。也就是说,猫爸其实是相当开放的,没有太多的限制,不然抓到这些数据就麻烦了。接下来启动R,下面是用rvest包抓取宝贝数据的过程

install.packages("rvest")

library(rvest)

gurl % # 读取gurl的链接,指定编码为gbk

html_nodes("div.product-iWrap") # 筛选出所有包含在...块的内容

<p># 抓取卖家昵称和ID

sellerNick % html_nodes("p.productStatus>span[class]") %>%

html_attr("data-nick")

sellerId % html_nodes("p.productStatus>span[data-atp]") %>%

html_attr("data-atp") %>%

gsub(pattern="^.*,",replacement="")

# 抓取宝贝名称等数据

itemTitle % html_nodes("p.productTitle>a[title]") %>%

html_attr("title")

itemId % html_nodes("p.productStatus>span[class]") %>%

html_attr("data-item")

price % html_nodes("em[title]") %>%

html_attr("title") %>%

as.numeric

volume % html_nodes("span>em") %>%

html_text

# 最后保存成数据框对象并存盘备用,以及写入csv文件

options(stringsAsFactors = FALSE) # 设置字符串不自动识别为因子

itemData %

gsub(pattern="/fang5",replacement="http://cs.ganji.com/fang5";)

# 缩略图链接

smallImg % html_nodes("dl>dt>div>a>img") %>% html_attr("src")

# 标题

iTitle % html_nodes("dl>dd>a") %>% html_attr("title")

# 户型

iLayout % html_nodes("dl>dd[data-huxing]") %>% html_attr("data-huxing")

# 面积

iArea % html_nodes("dl>dd[data-huxing]") %>%

html_attr("data-area") %>%

gsub(pattern="[^0-9]",replacement="")

# 筛选朝向等数据

iTmp % html_nodes("dl>dd[data-huxing]>span") %>% html_text

iOrientation % html_text %>%

gsub(pattern="\n",replacement=" ") %>%

gsub(pattern=" ",replacement="")

# 提取价格

iPrice % html_nodes("dl>dd>div.price>span:first-child") %>% html_text

# 提取单价

iTime % html_nodes("dl>dd>div.time") %>% html_text %>%

gsub(pattern="[^0-9]",replacement="") %>% as.numeric

# 合并数据框

iData

抓取网页数据(STM32)

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2022-02-18 16:20

一、urllib库的使用1、简单使用urllib库爬取整个网页源码

import urllib.request

url='http://www.baidu.com'

response=urllib.request.urlopen(url)

print(type(response)) #

print(dir(response)) # dir用来显示该对象所有的方法和属性

print(type(response.read())) #

print(response.read().decode()) # decode()默认使用UTF-8进行解码

print(response.geturl()) # http://www.baidu.com

print(response.getcode()) # 200

print(response.info()) # Bdpagetype: 1...

print(response.headers) # 和info()一样

2、简单使用urllib进行带参数的GET请求

import urllib.request

import urllib.parse

url='http://www.baidu.com/s'

params={'wd':'NBA全明星'} # 字典格式

params=urllib.parse.urlencode(params) # 对参数进行url编码

print(params) # wd=NBA%E5%85%A8%E6%98%8E%E6%98%9F

url=url+'?'+params # http://www.baidu.com/s%3Fwd%3D ... %259F

response=urllib.request.urlopen(url)

print(response.read().decode())

3、使用 urllib 发出 POST 请求

import urllib.request

import urllib.parse

url='http://httpbin.org/post'

data={'username':'恩比德','age':28}

data=urllib.parse.urlencode(data)

print(data) # username=%E6%81%A9%E6%AF%94%E5%BE%B7&age=28 url解码可使用urllib.parse.unquote(str)

data=bytes(data.encode()) # POST请求发送的数据必须是bytes,一般先要进行url编码,然后转换为bytes

request=urllib.request.Request(url,data=data) # 只要指定data参数,就一定是POST请求

response=urllib.request.urlopen(request) # 使用构造的Request对象,通过urlopen方法发送请求

print(response.read().decode())

4、使用urllib伪装成浏览器发出请求

import urllib.request

url='http://httpbin.org/get'

# User-Agent用来指定使用的浏览器

headers={'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.182 Safari/537.36'}

request=urllib.request.Request(url,headers=headers) # 指定headers参数构造Request对象

response=urllib.request.urlopen(request) # 使用Request对象发出请求

print(response.read().decode())

5、使用代理IP发出请求

import urllib.request

import random

# 免费的代理IP列表,zhimahttp.com,免费代理IP寿命短,速度慢,匿名度不高

proxy_list = [

{'http': '183.166.180.184:9999'},

{'http': '221.230.216.169:8888'},

{'http': '182.240.34.61:9999'},

{'http': '121.226.154.250:8080'}

]

proxy = random.choice(proxy_list) # 随机选择一个

print(proxy)

# 1.构造ProxyHandler

proxy_handler = urllib.request.ProxyHandler(proxy)

# 2.使用构造好的ProxyHandler对象来自定义opener对象

opener = urllib.request.build_opener(proxy_handler)

# 3.使用代理发出请求

request = urllib.request.Request('http://www.baidu.com') # 构造请求对象传入opener对象的open()方法

response = opener.open(request)

print(response.read().decode())

我们可以使用代理服务器并每隔一段时间更换一次代理。如果一个IP被封禁,可以换成另一个IP继续爬取数据,可以有效解决被网站封禁的情况。

6、URLError 异常并捕获

import urllib.request

import urllib.error

url='http://www.whit.edu.cn/net' # 错误url

request = urllib.request.Request(url)

try:

urllib.request.urlopen(request)

except urllib.error.HTTPError as e:

print(e.code) # 404

7、捕捉超时异常

import urllib.request

import urllib.error

try:

url = 'http://218.56.132.157:8080'

# timeout设置超时的时间

response = urllib.request.urlopen(url, timeout=1)

result = response.read()

print(result)

except Exception as error:

print(error) #

二、requests库的使用1、使用requests发出带参数的get请求

import requests

params={'wd':'爬虫'}

url='http://www.baidu.com/s'

response=requests.get(url,params=params)

print(response.text)

# print(type(response)) #

# print(response.encoding) # utf-8

# print(type(response.content)) #

# print(response.content.decode()) # 和response.text的结果一样

说明:使用request发送带参数的GET请求时,参数为字典格式,不带url编码,不拼接url。将此与“1”中的“2”进行比较。

Response 对象的常用属性:

text:响应内容的字符串形式

encoding:响应内容的编码

status_code:状态码

2、使用 requests 库发送 POST 请求

import requests

url="http://httpbin.org/post"

data={'name':'库里'} # POST请求要发送的数据

response=requests.post(url,data)

print(response.text)

注意:使用requests发送POST请求时,要发送的数据是字典格式,不需要URL编码,也不需要转换成字节。与“1”中的“3”比较。 查看全部

抓取网页数据(STM32)

一、urllib库的使用1、简单使用urllib库爬取整个网页源码

import urllib.request

url='http://www.baidu.com'

response=urllib.request.urlopen(url)

print(type(response)) #

print(dir(response)) # dir用来显示该对象所有的方法和属性

print(type(response.read())) #

print(response.read().decode()) # decode()默认使用UTF-8进行解码

print(response.geturl()) # http://www.baidu.com

print(response.getcode()) # 200

print(response.info()) # Bdpagetype: 1...

print(response.headers) # 和info()一样

2、简单使用urllib进行带参数的GET请求

import urllib.request

import urllib.parse

url='http://www.baidu.com/s'

params={'wd':'NBA全明星'} # 字典格式

params=urllib.parse.urlencode(params) # 对参数进行url编码

print(params) # wd=NBA%E5%85%A8%E6%98%8E%E6%98%9F

url=url+'?'+params # http://www.baidu.com/s%3Fwd%3D ... %259F

response=urllib.request.urlopen(url)

print(response.read().decode())

3、使用 urllib 发出 POST 请求

import urllib.request

import urllib.parse

url='http://httpbin.org/post'

data={'username':'恩比德','age':28}

data=urllib.parse.urlencode(data)

print(data) # username=%E6%81%A9%E6%AF%94%E5%BE%B7&age=28 url解码可使用urllib.parse.unquote(str)

data=bytes(data.encode()) # POST请求发送的数据必须是bytes,一般先要进行url编码,然后转换为bytes

request=urllib.request.Request(url,data=data) # 只要指定data参数,就一定是POST请求

response=urllib.request.urlopen(request) # 使用构造的Request对象,通过urlopen方法发送请求

print(response.read().decode())

4、使用urllib伪装成浏览器发出请求

import urllib.request

url='http://httpbin.org/get'

# User-Agent用来指定使用的浏览器

headers={'User-Agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.182 Safari/537.36'}

request=urllib.request.Request(url,headers=headers) # 指定headers参数构造Request对象

response=urllib.request.urlopen(request) # 使用Request对象发出请求

print(response.read().decode())

5、使用代理IP发出请求

import urllib.request

import random

# 免费的代理IP列表,zhimahttp.com,免费代理IP寿命短,速度慢,匿名度不高

proxy_list = [

{'http': '183.166.180.184:9999'},

{'http': '221.230.216.169:8888'},

{'http': '182.240.34.61:9999'},

{'http': '121.226.154.250:8080'}

]

proxy = random.choice(proxy_list) # 随机选择一个

print(proxy)

# 1.构造ProxyHandler

proxy_handler = urllib.request.ProxyHandler(proxy)

# 2.使用构造好的ProxyHandler对象来自定义opener对象

opener = urllib.request.build_opener(proxy_handler)

# 3.使用代理发出请求

request = urllib.request.Request('http://www.baidu.com') # 构造请求对象传入opener对象的open()方法

response = opener.open(request)

print(response.read().decode())

我们可以使用代理服务器并每隔一段时间更换一次代理。如果一个IP被封禁,可以换成另一个IP继续爬取数据,可以有效解决被网站封禁的情况。

6、URLError 异常并捕获

import urllib.request

import urllib.error

url='http://www.whit.edu.cn/net' # 错误url

request = urllib.request.Request(url)

try:

urllib.request.urlopen(request)

except urllib.error.HTTPError as e:

print(e.code) # 404

7、捕捉超时异常

import urllib.request

import urllib.error

try:

url = 'http://218.56.132.157:8080'

# timeout设置超时的时间

response = urllib.request.urlopen(url, timeout=1)

result = response.read()

print(result)

except Exception as error:

print(error) #

二、requests库的使用1、使用requests发出带参数的get请求

import requests

params={'wd':'爬虫'}

url='http://www.baidu.com/s'

response=requests.get(url,params=params)

print(response.text)

# print(type(response)) #

# print(response.encoding) # utf-8

# print(type(response.content)) #

# print(response.content.decode()) # 和response.text的结果一样

说明:使用request发送带参数的GET请求时,参数为字典格式,不带url编码,不拼接url。将此与“1”中的“2”进行比较。

Response 对象的常用属性:

text:响应内容的字符串形式

encoding:响应内容的编码

status_code:状态码

2、使用 requests 库发送 POST 请求

import requests

url="http://httpbin.org/post"

data={'name':'库里'} # POST请求要发送的数据

response=requests.post(url,data)

print(response.text)

注意:使用requests发送POST请求时,要发送的数据是字典格式,不需要URL编码,也不需要转换成字节。与“1”中的“3”比较。

抓取网页数据(字典批量获取数据打印的默认编码()(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2022-02-14 05:22

然后在第三步,我们更改了默认编码,这取决于你要爬取的网页的编码格式。如果不改的话,很有可能会出现乱码,或者一些看不见的字符。

第五步,我们将爬取的网页内容的前50个字符分配给内容供以后查看,因为网页太多,无法一次全部打印出来,所以我们决定将部分内容切片输出

最后一步,我们打印出刚刚保存的部分内容

前面只是为了提前熟悉爬取数据的步骤。接下来,我们通过列表字典批量获取数据,然后保存为文件

首先定义一个字典来存储我们要爬取的页面的URL

urls_dict = {

'特克斯博客': 'http://www.susmote.com/',

'百度': 'http://www.baidu.com',

'xyz': 'www.susmote.com',

'特克斯博客歌单区1': 'https://www.susmote.com/?cate=13',

'特克斯博客歌单区2': 'https://www.susmote.com/?cate=13'

}

然后我们在定义一个列表,里面也存储了爬取页面的URL

urls_lst = [

('特克斯博客', 'http://www.susmote.com/'),

('百度', 'http://www.baidu.com'),

('xyz', 'www.susmote.com'),

('特克斯博客歌单区1', 'https://www.susmote.com/?cate=13'),

('特克斯博客歌单区2', 'https://www.susmote.com/?cate=13')

]

然后我们先用字典来取

代码显示如下:

# 利用字典抓取

crawled_urls_for_dict = set()

for ind, name in enumerate(urls_dict.keys()):

name_url = urls_dict[name]

if name_url in crawled_urls_for_dict:

print(ind, name, "已经抓取过了.")

else:

try:

resp = requests.get(name_url)

except Exception as e:

print(ind, name, ":", str(e)[0:50])

continue

resp.encoding = "utf8"

content = resp.text

crawled_urls_for_dict.add(name_url)

with open("bydict_" + name + ".html", 'w', encoding='utf8') as f:

f.write(content)

print("抓取完成 : {} {}, 内容长度为{}".format(ind, name, len(content)))

首先定义一个空集合来保存我们已经刮过数据的URL,避免重复刮

后面我们通过for循环和枚举遍历每个字典的key和value,将每一个爬取的url存储到开头定义的set crawled_urls_for_dict中

然后我们判断要爬取的url是否已经保存在集合中,如果存在则输出已经爬取过

如果没有,请进行以下操作。这里,为了防止程序出错,影响程序的整体运行,我们使用try except语句打印错误异常,可以保证程序能够完整运行。

然后就像我之前说的,改变编码格式,暂时保存内容

只不过最后我们通过创建一个文件来保存爬取的网页文件。我不会详细解释这一点。无非就是加个后缀。

后面我们打印爬取网页的网址

for u in crawled_urls_for_dict:

print(u)

然后我们使用列表来抓取数据

代码显示如下

# 利用列表抓取

crawled_urls_for_list = set()

for ind, tup in enumerate(urls_lst):

name = tup[0]

name_url = tup[1]

if name_url in crawled_urls_for_list:

print(ind, name, "已经抓取过了.")

else:

try:

resp = requests.get(name_url)

except Exception as e:

print(ind, name, ":", str(e)[0:50])

continue

resp.encoding = "utf8"

content = resp.text

crawled_urls_for_list.add(name_url)

with open('bylist_' + name + ".html", "w", encoding='utf8') as f:

f.write(content)

print("抓取完成:{} {}, 内容长度为{}".format(ind, name, len(content)))

原理和之前的字典一样,就不过多解释了。

请注意这是一个嵌套列表,遍历时要小心

最后一样

for u in crawled_urls_for_list:

print(u)

打印抓取的数据

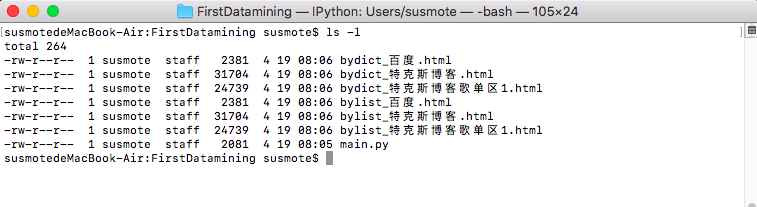

运行结果如下

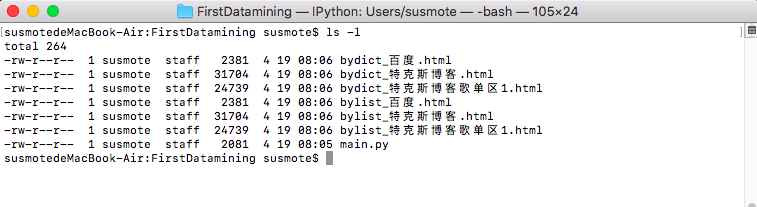

susmotedeMacBook-Air:FirstDatamining susmote$ python main.py

抓取完成 : 0 特克斯博客, 内容长度为26793

抓取完成 : 1 百度, 内容长度为2287

2 xyz : Invalid URL 'www.susmote.com': No schema supplied.

抓取完成 : 3 特克斯博客歌单区1, 内容长度为21728

4 特克斯博客歌单区2 已经抓取过了.

http://www.susmote.com/

http://www.baidu.com

https://www.susmote.com/?cate=13

------------------------------------------------------------

抓取完成:0 特克斯博客, 内容长度为26793

抓取完成:1 百度, 内容长度为2287

2 xyz : Invalid URL 'www.susmote.com': No schema supplied.

抓取完成:3 特克斯博客歌单区1, 内容长度为21728

4 特克斯博客歌单区2 已经抓取过了.

http://www.susmote.com/

http://www.baidu.com

https://www.susmote.com/?cate=13

文件目录变化如下

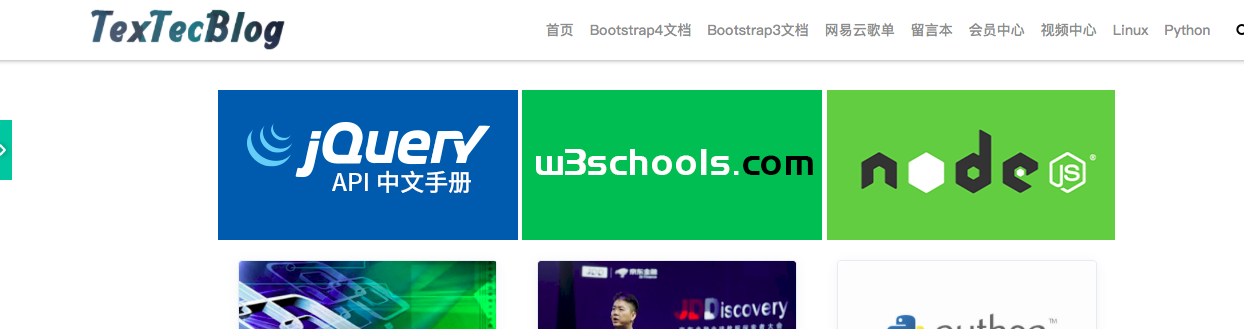

用浏览器打开如下图

德州博客

百度网站

至此,简单的数据采集就结束了。

欢迎来到我的官方网站 查看全部

抓取网页数据(字典批量获取数据打印的默认编码()(图))

然后在第三步,我们更改了默认编码,这取决于你要爬取的网页的编码格式。如果不改的话,很有可能会出现乱码,或者一些看不见的字符。

第五步,我们将爬取的网页内容的前50个字符分配给内容供以后查看,因为网页太多,无法一次全部打印出来,所以我们决定将部分内容切片输出

最后一步,我们打印出刚刚保存的部分内容

前面只是为了提前熟悉爬取数据的步骤。接下来,我们通过列表字典批量获取数据,然后保存为文件

首先定义一个字典来存储我们要爬取的页面的URL

urls_dict = {

'特克斯博客': 'http://www.susmote.com/',

'百度': 'http://www.baidu.com',

'xyz': 'www.susmote.com',

'特克斯博客歌单区1': 'https://www.susmote.com/?cate=13',

'特克斯博客歌单区2': 'https://www.susmote.com/?cate=13'

}

然后我们在定义一个列表,里面也存储了爬取页面的URL

urls_lst = [

('特克斯博客', 'http://www.susmote.com/'),

('百度', 'http://www.baidu.com'),

('xyz', 'www.susmote.com'),

('特克斯博客歌单区1', 'https://www.susmote.com/?cate=13'),

('特克斯博客歌单区2', 'https://www.susmote.com/?cate=13')

]

然后我们先用字典来取

代码显示如下:

# 利用字典抓取

crawled_urls_for_dict = set()

for ind, name in enumerate(urls_dict.keys()):

name_url = urls_dict[name]

if name_url in crawled_urls_for_dict:

print(ind, name, "已经抓取过了.")

else:

try:

resp = requests.get(name_url)

except Exception as e:

print(ind, name, ":", str(e)[0:50])

continue

resp.encoding = "utf8"

content = resp.text

crawled_urls_for_dict.add(name_url)

with open("bydict_" + name + ".html", 'w', encoding='utf8') as f:

f.write(content)

print("抓取完成 : {} {}, 内容长度为{}".format(ind, name, len(content)))

首先定义一个空集合来保存我们已经刮过数据的URL,避免重复刮

后面我们通过for循环和枚举遍历每个字典的key和value,将每一个爬取的url存储到开头定义的set crawled_urls_for_dict中

然后我们判断要爬取的url是否已经保存在集合中,如果存在则输出已经爬取过

如果没有,请进行以下操作。这里,为了防止程序出错,影响程序的整体运行,我们使用try except语句打印错误异常,可以保证程序能够完整运行。

然后就像我之前说的,改变编码格式,暂时保存内容

只不过最后我们通过创建一个文件来保存爬取的网页文件。我不会详细解释这一点。无非就是加个后缀。

后面我们打印爬取网页的网址

for u in crawled_urls_for_dict:

print(u)

然后我们使用列表来抓取数据

代码显示如下

# 利用列表抓取

crawled_urls_for_list = set()

for ind, tup in enumerate(urls_lst):

name = tup[0]

name_url = tup[1]

if name_url in crawled_urls_for_list:

print(ind, name, "已经抓取过了.")

else:

try:

resp = requests.get(name_url)

except Exception as e:

print(ind, name, ":", str(e)[0:50])

continue

resp.encoding = "utf8"

content = resp.text

crawled_urls_for_list.add(name_url)

with open('bylist_' + name + ".html", "w", encoding='utf8') as f:

f.write(content)

print("抓取完成:{} {}, 内容长度为{}".format(ind, name, len(content)))

原理和之前的字典一样,就不过多解释了。

请注意这是一个嵌套列表,遍历时要小心

最后一样

for u in crawled_urls_for_list:

print(u)

打印抓取的数据

运行结果如下

susmotedeMacBook-Air:FirstDatamining susmote$ python main.py

抓取完成 : 0 特克斯博客, 内容长度为26793

抓取完成 : 1 百度, 内容长度为2287

2 xyz : Invalid URL 'www.susmote.com': No schema supplied.

抓取完成 : 3 特克斯博客歌单区1, 内容长度为21728

4 特克斯博客歌单区2 已经抓取过了.

http://www.susmote.com/

http://www.baidu.com

https://www.susmote.com/?cate=13

------------------------------------------------------------

抓取完成:0 特克斯博客, 内容长度为26793

抓取完成:1 百度, 内容长度为2287

2 xyz : Invalid URL 'www.susmote.com': No schema supplied.

抓取完成:3 特克斯博客歌单区1, 内容长度为21728

4 特克斯博客歌单区2 已经抓取过了.

http://www.susmote.com/

http://www.baidu.com

https://www.susmote.com/?cate=13

文件目录变化如下

用浏览器打开如下图

德州博客

百度网站

至此,简单的数据采集就结束了。

欢迎来到我的官方网站

抓取网页数据(WebScrapping以非格式从网站中提取大量数据的技术。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2022-02-14 05:08

使用 Python 进行 Web Scraping 什么是 Web Scraping?

Web Scraping 是一种从多个 网站 中提取大量数据的技术。术语“爬行”是指从另一个来源(网页)获取信息并将其保存到本地文件。示例:假设您正在开展一个名为“手机比较网站”的项目,您需要手机价格、评级和型号名称来比较不同的手机。如果您通过检查各个站点来采集这些详细信息,则将花费很多时间。在这种情况下,网络报废起着重要的作用,只需编写几行代码,就可以得到想要的结果。

Web Scrapping 以非结构化格式从 网站 中提取数据。它有助于采集这些非结构化数据并将其转换为结构化形式。

初创公司更喜欢网络报废,因为它是一种无需与数据销售公司合作即可获取大量数据的廉价且有效的方式。

网上报废合法吗?

这里出现了在线报废是否合法的问题。答案是一些 网站 在合法使用时允许这样做。网页抓取只是一种工具,您可以正确或错误地使用它。

如果有人试图抓取非公开数据,则网络抓取是非法的。并非所有人都可以访问非公开数据;如果您试图提取此类数据是违法的。

有多种工具可用于从 网站 中抓取数据,例如:

为什么要报废一个网页?

正如我们上面所讨论的,网络抓取用于从 网站 中提取数据。但是我们应该知道如何使用这些原创数据。这些原创数据可用于各个领域。我们来看看网络报废的用法:

它被广泛用于从多个在线购物网站 中采集数据并比较产品价格并做出有利可图的定价决策。使用网络报废数据进行价格监控使公司能够了解市场状况并促进动态定价。它确保他们始终是一家优于其他公司的公司。

eb 废料是市场趋势分析的理想选择。它正在深入了解特定市场。大型组织需要大量数据,而网络过时为数据提供了有保证的可靠性和准确性。

许多公司使用个人电子邮件数据进行电子邮件营销。他们可以向特定的受众进行营销。

单个新闻周期可能会对您的业务产生重大影响或真正威胁。如果您的公司依赖于某个组织的新闻分析,那么它通常会出现在新闻中。因此,网络抓取为监控和解析最关键的故事提供了终极解决方案。新闻文章 和社交媒体平台可以直接影响股市。

Web Scrapping 在从 Twitter、Facebook 和 Instagram 网站 等社交媒体中提取数据以查找热门话题方面发挥着重要作用。

从 网站 中捕获大数据集,例如一般信息、统计数据、温度等,并进行分析以进行调查或研发。

为什么使用 Python 进行网页抓取?

还有其他流行的编程语言,但是为什么我们选择 Python 而不是其他编程语言进行网页抓取呢?下面我们将描述 Python 的特性列表,这些特性使其成为网络抓取最有用的编程语言。

在 Python 中,我们不需要为变量定义数据类型;我们可以在需要的地方直接使用该变量。它可以节省时间并使任务更快。Python 定义了它的类来识别变量的数据类型。

Python 附带了广泛的库,例如 NumPy、Matplotlib、Pandas、Scipy 等,它们为各种用途提供了灵活性。它适用于几乎所有新兴领域,以及用于提取数据和进行操作的网络抓取。

网页报废的目的是节省时间。但是如果你花更多的时间写代码呢?这就是我们使用 Python 的原因,因为它可以在几行代码中执行一项任务。

Python是开源的,这意味着每个人都可以免费使用。它拥有世界上最大的社区之一,如果您的 Python 代码有任何问题,您可以在其中寻求帮助。

网页抓取的基础知识

网络爬虫由两部分组成:网络爬虫和网络爬虫。简单地说,爬行动物是马,爬行动物是战车。爬虫引导爬虫并提取请求的数据。让我们看看网络报废的这两个组成部分:

网络爬虫通常被称为“蜘蛛”。它是一种人工智能技术,通过给定的链接浏览互联网以索引和搜索内容。它搜索程序员询问的相关信息。

刮刀

网络爬虫是一种专门的工具,旨在快速有效地从多个 网站 中提取数据。根据项目的不同,网络爬虫的设计和复杂性差异很大。

网络报废如何工作?

这些是执行网页抓取的以下步骤。让我们了解网络抓取的工作原理。

步骤 1:找到要抓取的 URL

首先,您应该根据您的项目了解数据的需求。网页或 网站 收录大量信息。这就是为什么只丢弃相关信息的原因。简单来说,开发人员应该熟悉数据需求。

步骤 - 2:检查页面

数据以原创 HTML 格式提取,必须仔细解析并减少原创数据中的噪声。在某些情况下,数据可以像姓名和地址一样简单,也可以像高维天气和股市数据一样复杂。

步骤 - 3:编写代码

编写代码以提取信息、提供相关信息并运行代码。

步骤 - 4:将数据存储在文件中

以所需的 csv、xml、JSON 文件格式存储此信息。

网页抓取入门

Python 有大量的库,也为网页抓取提供了一个非常有用的库。让我们了解Python所需的库。

用于网页抓取的库

pip install selenium

注意 - 最好使用 PyCharm IDE。

用于数据操作和分析的 Pandas 库。它用于提取数据并以所需的格式存储。

BeautifulSoup 是一个 Python 库,用于从 HTML 和 XML 文件中提取数据。它主要是为网页抓取而设计的。它与解析器一起工作,以提供一种自然的方式来导航、搜索和修改解析树。BeautifulSoup 的最新版本是 4.8.1。

让我们仔细看看 BeautifulSoup 库。

BeautifulSoup 的安装

您可以通过键入以下内容来安装 BeautifulSoup:

pip install bs4

安装解析器

BeautifulSoup 支持 HTML 解析器和几个第三方 Python 解析器。您可以根据您的依赖关系安装它们中的任何一个。BeautifulSoup 的解析器列表如下:

解析器的典型用法

用于 Python 的 html.parser

BeautifulSoup(标签,“html.parser”)

lxml 的 HTML 解析器

BeautifulSoup(标签,“lxml”)

lxml 的 XML 解析器

BeautifulSoup(标签,“lxml-xml”)

html5lib

BeautifulSoup(标签,“html5lib”)

我们建议您安装 html5lib 解析器,因为它适用于较新版本的 Python,或者您可以安装 lxml 解析器。

在终端中键入以下命令:

pip install html5lib

BeautifulSoup 用于将复杂的 HTML 文档转换为复杂的 Python 对象树。但是有一些最常用的基本类型的对象:

一个 Tag 对象对应于一个 XML 或 HTML 原创文档。

soup = bs4.BeautifulSoup("Extremely bold)

tag = soup.b

type(tag)

输出:

标签收录许多属性和方法,但标签最重要的特性是名称和属性。

每个标签都有一个名称,可以通过 .name 访问:

tag.name

一个标签可以有任意数量的属性。该标签有一个属性“id”,其值为“boldest”。我们可以通过将标签视为字典来访问标签的属性。

tag[id]

我们可以添加、删除和修改标签的属性。它可以通过使用标签作为字典来完成。

# add the element

tag['id'] = 'verybold'

tag['another-attribute'] = 1

tag

# delete the tag

del tag['id']

在 HTML5 中,某些属性可以有多个值。类(由多个 css 组成)是最常见的多值属性。其他属性是 rel、rev、accept-charset、headers 和 accesskey。

class_is_multi= { '*' : 'class'}

xml_soup = BeautifulSoup('', 'xml', multi_valued_attributes=class_is_multi)

xml_soup.p['class']

# [u'body', u'strikeout']

BeautifulSoup 中的字符串是指标签中的文本。BeautifulSoup 使用 NavigableString 类来收录这些文本位。

tag.string

# u'Extremely bold'

type(tag.string)

#

字符串是不可变的,这意味着它不能被编辑。但是可以使用 replace_with() 将其替换为另一个字符串。

tag.string.replace_with("No longer bold")

tag

在某些情况下,如果您想在 BeautifulSoup 之外使用 NavigableString,unicode() 可以帮助将其转换为普通的 Python Unicode 字符串。

BeautifulSoup 对象将完整的解析文档作为一个整体来表示。在很多情况下,我们可以将其用作 Tag 对象。这意味着它支持导航树和搜索树中描述的大多数方法。

<p>

doc=BeautifulSoup("INSERT FOOTER HERE 查看全部

抓取网页数据(WebScrapping以非格式从网站中提取大量数据的技术。)

使用 Python 进行 Web Scraping 什么是 Web Scraping?

Web Scraping 是一种从多个 网站 中提取大量数据的技术。术语“爬行”是指从另一个来源(网页)获取信息并将其保存到本地文件。示例:假设您正在开展一个名为“手机比较网站”的项目,您需要手机价格、评级和型号名称来比较不同的手机。如果您通过检查各个站点来采集这些详细信息,则将花费很多时间。在这种情况下,网络报废起着重要的作用,只需编写几行代码,就可以得到想要的结果。

Web Scrapping 以非结构化格式从 网站 中提取数据。它有助于采集这些非结构化数据并将其转换为结构化形式。

初创公司更喜欢网络报废,因为它是一种无需与数据销售公司合作即可获取大量数据的廉价且有效的方式。

网上报废合法吗?

这里出现了在线报废是否合法的问题。答案是一些 网站 在合法使用时允许这样做。网页抓取只是一种工具,您可以正确或错误地使用它。

如果有人试图抓取非公开数据,则网络抓取是非法的。并非所有人都可以访问非公开数据;如果您试图提取此类数据是违法的。

有多种工具可用于从 网站 中抓取数据,例如:

为什么要报废一个网页?

正如我们上面所讨论的,网络抓取用于从 网站 中提取数据。但是我们应该知道如何使用这些原创数据。这些原创数据可用于各个领域。我们来看看网络报废的用法:

它被广泛用于从多个在线购物网站 中采集数据并比较产品价格并做出有利可图的定价决策。使用网络报废数据进行价格监控使公司能够了解市场状况并促进动态定价。它确保他们始终是一家优于其他公司的公司。

eb 废料是市场趋势分析的理想选择。它正在深入了解特定市场。大型组织需要大量数据,而网络过时为数据提供了有保证的可靠性和准确性。

许多公司使用个人电子邮件数据进行电子邮件营销。他们可以向特定的受众进行营销。

单个新闻周期可能会对您的业务产生重大影响或真正威胁。如果您的公司依赖于某个组织的新闻分析,那么它通常会出现在新闻中。因此,网络抓取为监控和解析最关键的故事提供了终极解决方案。新闻文章 和社交媒体平台可以直接影响股市。

Web Scrapping 在从 Twitter、Facebook 和 Instagram 网站 等社交媒体中提取数据以查找热门话题方面发挥着重要作用。

从 网站 中捕获大数据集,例如一般信息、统计数据、温度等,并进行分析以进行调查或研发。

为什么使用 Python 进行网页抓取?

还有其他流行的编程语言,但是为什么我们选择 Python 而不是其他编程语言进行网页抓取呢?下面我们将描述 Python 的特性列表,这些特性使其成为网络抓取最有用的编程语言。

在 Python 中,我们不需要为变量定义数据类型;我们可以在需要的地方直接使用该变量。它可以节省时间并使任务更快。Python 定义了它的类来识别变量的数据类型。

Python 附带了广泛的库,例如 NumPy、Matplotlib、Pandas、Scipy 等,它们为各种用途提供了灵活性。它适用于几乎所有新兴领域,以及用于提取数据和进行操作的网络抓取。

网页报废的目的是节省时间。但是如果你花更多的时间写代码呢?这就是我们使用 Python 的原因,因为它可以在几行代码中执行一项任务。

Python是开源的,这意味着每个人都可以免费使用。它拥有世界上最大的社区之一,如果您的 Python 代码有任何问题,您可以在其中寻求帮助。

网页抓取的基础知识

网络爬虫由两部分组成:网络爬虫和网络爬虫。简单地说,爬行动物是马,爬行动物是战车。爬虫引导爬虫并提取请求的数据。让我们看看网络报废的这两个组成部分:

网络爬虫通常被称为“蜘蛛”。它是一种人工智能技术,通过给定的链接浏览互联网以索引和搜索内容。它搜索程序员询问的相关信息。

刮刀

网络爬虫是一种专门的工具,旨在快速有效地从多个 网站 中提取数据。根据项目的不同,网络爬虫的设计和复杂性差异很大。

网络报废如何工作?

这些是执行网页抓取的以下步骤。让我们了解网络抓取的工作原理。

步骤 1:找到要抓取的 URL

首先,您应该根据您的项目了解数据的需求。网页或 网站 收录大量信息。这就是为什么只丢弃相关信息的原因。简单来说,开发人员应该熟悉数据需求。

步骤 - 2:检查页面

数据以原创 HTML 格式提取,必须仔细解析并减少原创数据中的噪声。在某些情况下,数据可以像姓名和地址一样简单,也可以像高维天气和股市数据一样复杂。

步骤 - 3:编写代码

编写代码以提取信息、提供相关信息并运行代码。

步骤 - 4:将数据存储在文件中

以所需的 csv、xml、JSON 文件格式存储此信息。

网页抓取入门

Python 有大量的库,也为网页抓取提供了一个非常有用的库。让我们了解Python所需的库。

用于网页抓取的库

pip install selenium

注意 - 最好使用 PyCharm IDE。

用于数据操作和分析的 Pandas 库。它用于提取数据并以所需的格式存储。

BeautifulSoup 是一个 Python 库,用于从 HTML 和 XML 文件中提取数据。它主要是为网页抓取而设计的。它与解析器一起工作,以提供一种自然的方式来导航、搜索和修改解析树。BeautifulSoup 的最新版本是 4.8.1。

让我们仔细看看 BeautifulSoup 库。

BeautifulSoup 的安装

您可以通过键入以下内容来安装 BeautifulSoup:

pip install bs4

安装解析器

BeautifulSoup 支持 HTML 解析器和几个第三方 Python 解析器。您可以根据您的依赖关系安装它们中的任何一个。BeautifulSoup 的解析器列表如下:

解析器的典型用法

用于 Python 的 html.parser

BeautifulSoup(标签,“html.parser”)

lxml 的 HTML 解析器

BeautifulSoup(标签,“lxml”)

lxml 的 XML 解析器

BeautifulSoup(标签,“lxml-xml”)

html5lib

BeautifulSoup(标签,“html5lib”)

我们建议您安装 html5lib 解析器,因为它适用于较新版本的 Python,或者您可以安装 lxml 解析器。

在终端中键入以下命令:

pip install html5lib

BeautifulSoup 用于将复杂的 HTML 文档转换为复杂的 Python 对象树。但是有一些最常用的基本类型的对象:

一个 Tag 对象对应于一个 XML 或 HTML 原创文档。

soup = bs4.BeautifulSoup("Extremely bold)

tag = soup.b

type(tag)

输出:

标签收录许多属性和方法,但标签最重要的特性是名称和属性。

每个标签都有一个名称,可以通过 .name 访问:

tag.name

一个标签可以有任意数量的属性。该标签有一个属性“id”,其值为“boldest”。我们可以通过将标签视为字典来访问标签的属性。

tag[id]

我们可以添加、删除和修改标签的属性。它可以通过使用标签作为字典来完成。

# add the element

tag['id'] = 'verybold'

tag['another-attribute'] = 1

tag

# delete the tag

del tag['id']

在 HTML5 中,某些属性可以有多个值。类(由多个 css 组成)是最常见的多值属性。其他属性是 rel、rev、accept-charset、headers 和 accesskey。

class_is_multi= { '*' : 'class'}

xml_soup = BeautifulSoup('', 'xml', multi_valued_attributes=class_is_multi)

xml_soup.p['class']

# [u'body', u'strikeout']

BeautifulSoup 中的字符串是指标签中的文本。BeautifulSoup 使用 NavigableString 类来收录这些文本位。

tag.string

# u'Extremely bold'

type(tag.string)

#

字符串是不可变的,这意味着它不能被编辑。但是可以使用 replace_with() 将其替换为另一个字符串。

tag.string.replace_with("No longer bold")

tag

在某些情况下,如果您想在 BeautifulSoup 之外使用 NavigableString,unicode() 可以帮助将其转换为普通的 Python Unicode 字符串。

BeautifulSoup 对象将完整的解析文档作为一个整体来表示。在很多情况下,我们可以将其用作 Tag 对象。这意味着它支持导航树和搜索树中描述的大多数方法。

<p>

doc=BeautifulSoup("INSERT FOOTER HERE

抓取网页数据(动态网页数据源获取需要抓取的页面是什么意思?|)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-02-10 22:30

在做一些数据采集工作之前,也踩过一些坑,所以有了这个文章。

动态网页数据源获取

需要爬取的页面是使用React JavaScript框架开发的,所有的页面都是在客户端渲染的,也就是说我只能一一看到data-id,没有办法获取数据直接地。这涉及到一个我之前没有接触过的领域——动态网络爬取。google了一下,了解到动态网页爬取一般可以通过以下两种方式实现:

第二种方式相当于在命令行运行浏览器,一次打开一页,效率可想而知。另外,要爬取的页面的DOM结构比较复杂,并且没有添加对应的class和id,即使渲染后也很难抓取到自己需要的数据。所以只能采用第一种方案:分析网页的代码后发现所有的数据都是通过一个接口返回的。使用 Chrome 检查工具中的网络工具获取所有网络请求,在其中搜索 JSON,找到一个 JSON 请求。点击它正是我们需要的数据,解决了动态web数据源的问题。

分类不统一

这个坑主要是目标网页的数据挖掘不足。一开始以为目标页面是按照具体的分类来分类的,后来发现这个标准不统一,最后抓到的数据也不是一维的。就在我准备开始写很多特别判断的时候,我发现如果我从另一个维度去求数据,所有的数据都会统一起来。在这种情况下,将人工分类切换为通过价格获取数据。通过选择所有的价格,可以得到所有的数据,不需要对不同维度的分类做特殊判断。这与其说是技术问题,不如说是经验问题。

页面内部的JS执行

这个坑比较有意思。目标网页除了通过特定的接口获取数据外,还通过页面内部的 JavaScript 直接传递数据。其背后的技术考虑尚不清楚,但摆在我面前的问题是如何获取这段 JavaScript 代码中的数据。想了一会儿,我想出了两个选择:

自匹配的问题是我需要匹配的字符串格式不同,很难直接匹配到我需要的数据。并且通过 phatomjs 执行,可以更好的解决这个问题。

一个肮脏的解决方案是:

将整个 HTML 页面下载到 test.html 以获取所有 查看全部

抓取网页数据(动态网页数据源获取需要抓取的页面是什么意思?|)

在做一些数据采集工作之前,也踩过一些坑,所以有了这个文章。

动态网页数据源获取

需要爬取的页面是使用React JavaScript框架开发的,所有的页面都是在客户端渲染的,也就是说我只能一一看到data-id,没有办法获取数据直接地。这涉及到一个我之前没有接触过的领域——动态网络爬取。google了一下,了解到动态网页爬取一般可以通过以下两种方式实现:

第二种方式相当于在命令行运行浏览器,一次打开一页,效率可想而知。另外,要爬取的页面的DOM结构比较复杂,并且没有添加对应的class和id,即使渲染后也很难抓取到自己需要的数据。所以只能采用第一种方案:分析网页的代码后发现所有的数据都是通过一个接口返回的。使用 Chrome 检查工具中的网络工具获取所有网络请求,在其中搜索 JSON,找到一个 JSON 请求。点击它正是我们需要的数据,解决了动态web数据源的问题。

分类不统一

这个坑主要是目标网页的数据挖掘不足。一开始以为目标页面是按照具体的分类来分类的,后来发现这个标准不统一,最后抓到的数据也不是一维的。就在我准备开始写很多特别判断的时候,我发现如果我从另一个维度去求数据,所有的数据都会统一起来。在这种情况下,将人工分类切换为通过价格获取数据。通过选择所有的价格,可以得到所有的数据,不需要对不同维度的分类做特殊判断。这与其说是技术问题,不如说是经验问题。

页面内部的JS执行

这个坑比较有意思。目标网页除了通过特定的接口获取数据外,还通过页面内部的 JavaScript 直接传递数据。其背后的技术考虑尚不清楚,但摆在我面前的问题是如何获取这段 JavaScript 代码中的数据。想了一会儿,我想出了两个选择:

自匹配的问题是我需要匹配的字符串格式不同,很难直接匹配到我需要的数据。并且通过 phatomjs 执行,可以更好的解决这个问题。

一个肮脏的解决方案是:

将整个 HTML 页面下载到 test.html 以获取所有

抓取网页数据(官方rstudio|r语言开发者社区datagururstudiorequestsindex爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-02-09 06:07

抓取网页数据,然后统计每年的销量。我在一家上市公司供职,我的主要业务是把不同企业的各种数据发送到我们公司的数据库。比如我们公司做了500+企业,平均每个企业有23亿的数据,我发送一个邮件或者文件,然后把这个邮件或者文件里面的信息全部索引,做成一个excel表,然后统计每年有多少产品卖出去,卖了多少亿元。

做过一个软件可以做到:爬取手机数据,比如运营商监测的网站上面的数据,然后实时将数据解析上传到自己的数据库里,然后对应上年销量。

爬取网页信息,关键的关键是url。

可以用无线网格式识别,

是数据分析师吧。爬虫api?就是获取各个网站的数据,

爬虫。

快速解决需求的话还是要用r语言。官方rstudio|r语言开发者社区datagururstudiorequestsindex爬虫的话,可以先用python爬虫,然后用r语言实现。

百度统计

需求是谁提的?如果不是爬虫爬取的,就要想办法让爬虫不能爬取爬取一年内的信息。

网页只是你推荐的各个网站关联链接的结构化数据,

我的解决方案是给爬虫配个小电脑,手机和ipad也可以用,用开发的爬虫脚本将这些数据聚合在一起。然后从网页抓取,然后回归真实结构去分析,如果还要处理的话就比较麻烦了,涉及关联规则等一些抽象的东西。 查看全部

抓取网页数据(官方rstudio|r语言开发者社区datagururstudiorequestsindex爬虫)

抓取网页数据,然后统计每年的销量。我在一家上市公司供职,我的主要业务是把不同企业的各种数据发送到我们公司的数据库。比如我们公司做了500+企业,平均每个企业有23亿的数据,我发送一个邮件或者文件,然后把这个邮件或者文件里面的信息全部索引,做成一个excel表,然后统计每年有多少产品卖出去,卖了多少亿元。

做过一个软件可以做到:爬取手机数据,比如运营商监测的网站上面的数据,然后实时将数据解析上传到自己的数据库里,然后对应上年销量。

爬取网页信息,关键的关键是url。

可以用无线网格式识别,

是数据分析师吧。爬虫api?就是获取各个网站的数据,

爬虫。

快速解决需求的话还是要用r语言。官方rstudio|r语言开发者社区datagururstudiorequestsindex爬虫的话,可以先用python爬虫,然后用r语言实现。

百度统计

需求是谁提的?如果不是爬虫爬取的,就要想办法让爬虫不能爬取爬取一年内的信息。

网页只是你推荐的各个网站关联链接的结构化数据,

我的解决方案是给爬虫配个小电脑,手机和ipad也可以用,用开发的爬虫脚本将这些数据聚合在一起。然后从网页抓取,然后回归真实结构去分析,如果还要处理的话就比较麻烦了,涉及关联规则等一些抽象的东西。

抓取网页数据(Python数据抓取分析编程模块:requests.document_fromstring(url))

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2022-02-09 01:41

Python数据抓取分析

编程模块:requests、lxml、pymongo、time、BeautifulSoup

首先获取所有产品的分类网址:

def step():

try:

headers = {

。。。。。

}

r = requests.get(url,headers,timeout=30)

html = r.content

soup = BeautifulSoup(html,"lxml")

url = soup.find_all(正则表达式)

for i in url:

url2 = i.find_all('a')

for j in url2:

step1url =url + j['href']

print step1url

step2(step1url)

except Exception,e:

print e

我们在对产品进行分类的时候,需要判断我们访问的地址是一个产品还是另一个分类的产品地址(所以我们需要判断我们访问的地址是否收录if判断标志):

def step2(step1url):

try:

headers = {

。。。。

}

r = requests.get(step1url,headers,timeout=30)

html = r.content

soup = BeautifulSoup(html,"lxml")

a = soup.find('div',id='divTbl')

if a:

url = soup.find_all('td',class_='S-ITabs')

for i in url:

classifyurl = i.find_all('a')

for j in classifyurl:

step2url = url + j['href']

#print step2url

step3(step2url)

else:

postdata(step1url)

当我们的if判断为真时,会得到第二个页面的分类URL(第一步),否则会执行postdata函数去抓取网页的产品地址!

def producturl(url):

try:

p1url = doc.xpath(正则表达式)

for i in xrange(1,len(p1url) + 1):

p2url = doc.xpath(正则表达式)

if len(p2url) > 0:

producturl = url + p2url[0].get('href')

count = db[table].find({'url':producturl}).count()

if count 1:

td = i.find_all('td')

key=td[0].get_text().strip().replace(',','')

val=td[1].get_text().replace(u'\u20ac','').strip()

if key and val:

cost[key] = val

if cost:

dt['cost'] = cost

dt['currency'] = 'EUR'

#quantity

d = soup.find("input",id="ItemQuantity")

if d:

dt['quantity'] = d['value']

#specs

e = soup.find("div",class_="row parameter-container")

if e:

key1 = []

val1= []

for k in e.find_all('dt'):

key = k.get_text().strip().strip('.')

if key:

key1.append(key)

for i in e.find_all('dd'):

val = i.get_text().strip()

if val:

val1.append(val)

specs = dict(zip(key1,val1))

if specs:

dt['specs'] = specs

print dt

if dt:

db[table].update({'sn':sn},{'$set':dt})

print str(sn) + ' insert successfully'

time.sleep(3)

else:

error(str(sn) + '\t' + url)

except Exception,e:

error(str(sn) + '\t' + url)

print "Don't data!"

最后,所有程序运行,数值数据分析处理后存入数据库!

以上就是本文详细介绍python+mongodb数据爬取的全部内容,希望对大家有所帮助。有兴趣的朋友可以继续参考本站:Python探索创建二叉树、Python探索修改Python搜索路径、说说python中copy和deepcopy的区别等,如有疑问请留言交流和讨论。 查看全部

抓取网页数据(Python数据抓取分析编程模块:requests.document_fromstring(url))

Python数据抓取分析

编程模块:requests、lxml、pymongo、time、BeautifulSoup

首先获取所有产品的分类网址:

def step():

try:

headers = {

。。。。。

}

r = requests.get(url,headers,timeout=30)

html = r.content

soup = BeautifulSoup(html,"lxml")

url = soup.find_all(正则表达式)

for i in url:

url2 = i.find_all('a')

for j in url2:

step1url =url + j['href']

print step1url

step2(step1url)

except Exception,e:

print e

我们在对产品进行分类的时候,需要判断我们访问的地址是一个产品还是另一个分类的产品地址(所以我们需要判断我们访问的地址是否收录if判断标志):

def step2(step1url):

try:

headers = {

。。。。

}

r = requests.get(step1url,headers,timeout=30)

html = r.content

soup = BeautifulSoup(html,"lxml")

a = soup.find('div',id='divTbl')

if a:

url = soup.find_all('td',class_='S-ITabs')

for i in url:

classifyurl = i.find_all('a')

for j in classifyurl:

step2url = url + j['href']

#print step2url

step3(step2url)

else:

postdata(step1url)

当我们的if判断为真时,会得到第二个页面的分类URL(第一步),否则会执行postdata函数去抓取网页的产品地址!

def producturl(url):

try:

p1url = doc.xpath(正则表达式)

for i in xrange(1,len(p1url) + 1):

p2url = doc.xpath(正则表达式)

if len(p2url) > 0:

producturl = url + p2url[0].get('href')

count = db[table].find({'url':producturl}).count()

if count 1:

td = i.find_all('td')

key=td[0].get_text().strip().replace(',','')

val=td[1].get_text().replace(u'\u20ac','').strip()

if key and val:

cost[key] = val

if cost:

dt['cost'] = cost

dt['currency'] = 'EUR'

#quantity

d = soup.find("input",id="ItemQuantity")

if d:

dt['quantity'] = d['value']

#specs

e = soup.find("div",class_="row parameter-container")

if e:

key1 = []

val1= []

for k in e.find_all('dt'):

key = k.get_text().strip().strip('.')

if key:

key1.append(key)

for i in e.find_all('dd'):

val = i.get_text().strip()

if val:

val1.append(val)

specs = dict(zip(key1,val1))

if specs:

dt['specs'] = specs

print dt

if dt:

db[table].update({'sn':sn},{'$set':dt})

print str(sn) + ' insert successfully'

time.sleep(3)

else:

error(str(sn) + '\t' + url)

except Exception,e:

error(str(sn) + '\t' + url)

print "Don't data!"

最后,所有程序运行,数值数据分析处理后存入数据库!

以上就是本文详细介绍python+mongodb数据爬取的全部内容,希望对大家有所帮助。有兴趣的朋友可以继续参考本站:Python探索创建二叉树、Python探索修改Python搜索路径、说说python中copy和deepcopy的区别等,如有疑问请留言交流和讨论。

抓取网页数据(欧记,跟51一起写你的搜索引擎(seo))

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-02-07 18:03

抓取网页数据并进行筛选,匹配条件,按顺序提取数据,分析数据,最后可做出思维导图。1.浏览器搜索框输入:80/javascript/2.浏览器打开路径:80/javascript/webdriver/3.浏览器浏览,展示页面3.1右键点击“运行”3.2右键点击“浏览器窗口管理”3.3右键点击“扩展程序”3.4右键点击“浏览器以管理员身份运行”3.5打开网页文件夹,选择“文件”,找到名为.csv的文件,右键“打开方式”改为“浏览器”3.6右键选择“修改文件类型”“查看”3.7右键选择“更改文件扩展名”3.8打开文件浏览器路径\webdriver\webdriver.crx2.1点击菜单“新建记录"2.2把要搜索的内容复制到记录名,点击确定,展示搜索结果。

首先你得下一个浏览器

我们都知道,用户想要通过浏览器找到想要的数据,关键是需要找到数据在页面的哪个位置。一般来说,浏览器自带的一些搜索功能是基本够用的,但是,这就像根据地图找标的人一样,找到了你就找到了全国各地你,但你在哪,可就不一定了。要是你打算在北京工作,想找个重庆的工作可就麻烦了。如果你自己另建了个网站,或者自己想独立开发个平台,这个时候如果没有第三方的服务,就只能自己大海捞针。

如果有一款可以查找搜索和在线编辑页面网址的产品,就完美了。我是欧记,跟51一起写你的搜索引擎(seo)。 查看全部

抓取网页数据(欧记,跟51一起写你的搜索引擎(seo))

抓取网页数据并进行筛选,匹配条件,按顺序提取数据,分析数据,最后可做出思维导图。1.浏览器搜索框输入:80/javascript/2.浏览器打开路径:80/javascript/webdriver/3.浏览器浏览,展示页面3.1右键点击“运行”3.2右键点击“浏览器窗口管理”3.3右键点击“扩展程序”3.4右键点击“浏览器以管理员身份运行”3.5打开网页文件夹,选择“文件”,找到名为.csv的文件,右键“打开方式”改为“浏览器”3.6右键选择“修改文件类型”“查看”3.7右键选择“更改文件扩展名”3.8打开文件浏览器路径\webdriver\webdriver.crx2.1点击菜单“新建记录"2.2把要搜索的内容复制到记录名,点击确定,展示搜索结果。

首先你得下一个浏览器

我们都知道,用户想要通过浏览器找到想要的数据,关键是需要找到数据在页面的哪个位置。一般来说,浏览器自带的一些搜索功能是基本够用的,但是,这就像根据地图找标的人一样,找到了你就找到了全国各地你,但你在哪,可就不一定了。要是你打算在北京工作,想找个重庆的工作可就麻烦了。如果你自己另建了个网站,或者自己想独立开发个平台,这个时候如果没有第三方的服务,就只能自己大海捞针。

如果有一款可以查找搜索和在线编辑页面网址的产品,就完美了。我是欧记,跟51一起写你的搜索引擎(seo)。

抓取网页数据(西安网络推广如何提高搜索引擎的量呢量呢)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-02-05 17:24

网站上线后,如果西安网促想要有更高的排名,获得更多的流量,那么就需要一定的爬虫,更好的帮助网站积累实力,提升排名,那么网站如何提高搜索引擎的爬取量?下面西安网络推广带你一起来了解一下。

1、网站更新频率

定期更新高价值内容的网站会很受蜘蛛们的欢迎和喜爱,因为无论蜘蛛如何改变算法,它们都喜欢新鲜、创新和优质的内容。规则不变,所以优化者不妨做好全方位的内容优化,提高爬虫爬取和爬取率。

2、网站人气

网站 的流行度指的是用户体验。对于用户体验好的网站,百度蜘蛛肯定会优先爬取,而网站如果布局合理,结构清晰,更有利于蜘蛛的爬取和爬取,然后帮助 网站 排名提高。

3、外部链接

西安网络推广表示,优质网站先于网站,百度对垃圾外链的过滤非常严格,但真正的优质外链对于排名和爬取还是很有用的。

4、历史爬取效果不错

对于一个网站域名,无论是百度排名还是蜘蛛抓取,历史记录也很重要。如果之前的网站域名受到了处罚,可能影响很大。蜘蛛爬爬爬,所以大家也要确保坐好网站从头到尾优化。

5、服务器稳定

服务器稳定性包括稳定性和速度两个方面。服务器越快,爬虫的效率就越高,这对用户体验也有一定的影响。

以上是西网推广为大家总结的几点,可以帮助网站增加爬取量,提高收录的优化技巧。通过上面的介绍,相信你也会对网站有更好的优化。了解更多并帮助 网站 发展得越来越好。 查看全部

抓取网页数据(西安网络推广如何提高搜索引擎的量呢量呢)

网站上线后,如果西安网促想要有更高的排名,获得更多的流量,那么就需要一定的爬虫,更好的帮助网站积累实力,提升排名,那么网站如何提高搜索引擎的爬取量?下面西安网络推广带你一起来了解一下。

1、网站更新频率

定期更新高价值内容的网站会很受蜘蛛们的欢迎和喜爱,因为无论蜘蛛如何改变算法,它们都喜欢新鲜、创新和优质的内容。规则不变,所以优化者不妨做好全方位的内容优化,提高爬虫爬取和爬取率。

2、网站人气

网站 的流行度指的是用户体验。对于用户体验好的网站,百度蜘蛛肯定会优先爬取,而网站如果布局合理,结构清晰,更有利于蜘蛛的爬取和爬取,然后帮助 网站 排名提高。

3、外部链接

西安网络推广表示,优质网站先于网站,百度对垃圾外链的过滤非常严格,但真正的优质外链对于排名和爬取还是很有用的。

4、历史爬取效果不错

对于一个网站域名,无论是百度排名还是蜘蛛抓取,历史记录也很重要。如果之前的网站域名受到了处罚,可能影响很大。蜘蛛爬爬爬,所以大家也要确保坐好网站从头到尾优化。

5、服务器稳定

服务器稳定性包括稳定性和速度两个方面。服务器越快,爬虫的效率就越高,这对用户体验也有一定的影响。

以上是西网推广为大家总结的几点,可以帮助网站增加爬取量,提高收录的优化技巧。通过上面的介绍,相信你也会对网站有更好的优化。了解更多并帮助 网站 发展得越来越好。

抓取网页数据( 小编来一起如何用python来抓取页面中的数据? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2022-02-05 04:12

小编来一起如何用python来抓取页面中的数据?

)

浅谈如何使用python抓取网页中的动态数据

更新时间:2020-08-17 11:08:10 作者:saintlas

本篇文章主要介绍如何使用python抓取网页中的动态数据。文章中对示例代码进行了非常详细的介绍。对大家的学习或工作有一定的参考和学习价值。需要的小伙伴一起来和小编一起学习吧

我们经常会发现网页中的很多数据并不是用 HTML 编写的,而是通过 js 动态加载的。因此,引入了动态数据的概念。这里的动态数据是指网页中通过Javascript动态生成的页面内容。它是在页面加载到浏览器后动态生成的,但之前没有。

在编写爬虫爬取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果还是直接从网页爬取,就无法获取任何数据。

今天就简单讲一下如何使用python爬取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面获取有关每部电影的信息。

如下图所示,我们在 HTML 中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开网络中的XHR,我们抓取对应的js文件进行解析。如下所示:

在豆瓣页面上拖拽,让页面加载更多的电影信息,方便我们抓取对应的消息。

我们可以看到它使用了 AJAX 异步请求。AJAX 可以通过在后台与服务器交换少量数据来异步更新网页。因此,可以在不重新加载整个网页的情况下更新网页的一部分,从而实现数据的动态加载。

我们可以看到,通过 GET,我们得到的响应中收录了对应的电影相关信息,并以 JSON 格式保存在一起。

查看RequestURL信息,我们可以看到action参数后面有两个参数“start”和“limit”,很明显的意思是:“从某个位置返回的电影数量”。

如果想快速获取相关电影信息,可以直接将网址复制到地址栏,修改自己需要的start和limit参数值,抓取对应的结果。

但这看起来很不自动化,网站的其他很多RequestURL也没有那么直接,所以我们会使用python进行进一步的操作来获取返回的消息信息。

#coding:utf-8

import urllib

import requests

post_param = {'action':'','start':'0','limit':'1'}

return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False)

print return_data.text 查看全部

抓取网页数据(

小编来一起如何用python来抓取页面中的数据?

)

浅谈如何使用python抓取网页中的动态数据

更新时间:2020-08-17 11:08:10 作者:saintlas

本篇文章主要介绍如何使用python抓取网页中的动态数据。文章中对示例代码进行了非常详细的介绍。对大家的学习或工作有一定的参考和学习价值。需要的小伙伴一起来和小编一起学习吧

我们经常会发现网页中的很多数据并不是用 HTML 编写的,而是通过 js 动态加载的。因此,引入了动态数据的概念。这里的动态数据是指网页中通过Javascript动态生成的页面内容。它是在页面加载到浏览器后动态生成的,但之前没有。

在编写爬虫爬取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果还是直接从网页爬取,就无法获取任何数据。

今天就简单讲一下如何使用python爬取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面获取有关每部电影的信息。

如下图所示,我们在 HTML 中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开网络中的XHR,我们抓取对应的js文件进行解析。如下所示:

在豆瓣页面上拖拽,让页面加载更多的电影信息,方便我们抓取对应的消息。

我们可以看到它使用了 AJAX 异步请求。AJAX 可以通过在后台与服务器交换少量数据来异步更新网页。因此,可以在不重新加载整个网页的情况下更新网页的一部分,从而实现数据的动态加载。

我们可以看到,通过 GET,我们得到的响应中收录了对应的电影相关信息,并以 JSON 格式保存在一起。

查看RequestURL信息,我们可以看到action参数后面有两个参数“start”和“limit”,很明显的意思是:“从某个位置返回的电影数量”。

如果想快速获取相关电影信息,可以直接将网址复制到地址栏,修改自己需要的start和limit参数值,抓取对应的结果。

但这看起来很不自动化,网站的其他很多RequestURL也没有那么直接,所以我们会使用python进行进一步的操作来获取返回的消息信息。

#coding:utf-8

import urllib

import requests

post_param = {'action':'','start':'0','limit':'1'}

return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False)

print return_data.text

抓取网页数据( 网站优化之规范代码规范化换行的Html代码对一个网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-03-11 12:19

网站优化之规范代码规范化换行的Html代码对一个网站)

网站优化的标准HTML代码

规范化的 Html 代码对于 网站 有很多好处,例如:易于修改、易于代码维护、代码量大

如何优化 HTML网站 代码

一个高质量的网站,网站代码的优化是非常重要的。对于一个好的SEO人来说,虽然不需要精通代码,但是一些简单的基本代码还是需要懂的。要想成为优秀的SEO人眼,需要有不断学习的精神。我们的网站 中的某个页面需要网站 代码优化。如果想看懂代码,可以给网站的添加附加值,有利于蜘蛛爬网

增长知识!网站哪些html代码需要针对seo进行优化?

关于seo,大部分人看到的界面都是用html代码组织的。优化网站html代码的目的是为了让网站更适合搜索引擎。精致的网站一端适合用户,另一端适合

git 拉取代码到本地

git拉码到本地的方法是:先打开git命令窗口,输入命令【gitclonegithub仓库地址】;然后回车拉码到本地仓库。第一步:拉取远程代码 gitclone

如何在html中直接显示html代码

本文文章将介绍在html中直接显示html代码的方式。有一定的参考价值,有需要的朋友可以参考,希望对大家有所帮助。百度做了很多实践,感觉很多都没有测试过就废话了。

如何编写html换行代码

html换行代码是“

",在要换行的行末尾,添加"

《代码可以实现换行操作.html》

”标签用于插入简单的换行符,实现换行。本教程运行环境:win

关于精简网站代码优化技巧

在网站的基础seo优化中,精简CSS代码和精简HTML代码是一项重要的优化技术。代码的简化直接影响到搜索引擎爬取网站的效果,因为搜索引擎爬取的第一步是网站的文章内容。严重影响搜索引擎抓取文章内容的效果。代码简化后,不仅可以增加网站的文字内容比例,还可以

关于精简网站代码优化技巧

在网站的基础seo优化中,精简CSS代码和精简HTML代码是一项重要的优化技术。代码的简化直接影响到搜索引擎爬取网站的效果,因为搜索引擎爬取的第一步是网站的文章内容。严重影响搜索引擎抓取文章内容的效果。代码简化后,不仅可以增加网站的文字内容比例,还可以

html中的空格代码是什么

HTML空格码就是HTML空格字符码,由“&+n+b+s+p+;”组成,记住最后一个分号不要忘记。在 CSS 中,当 white-space 属性的值为 pre 时,浏览器会在文本中保留空格和换行符,例如:

如何在vscode中运行html代码

本文文章将介绍在vscode中运行html代码的方式。有一定的参考价值,有需要的朋友可以参考,希望对大家有所帮助。如何在vscode中运行html代码:点击vscode软件左侧的扩展

html常用代码

1:粗斜体代码 ◆粗体代码为:Hello ◆斜体代码为:Hello!◆底线字: 2:文本链接代码 如果你想点击某个文本连接到另一个网页,这是一个超链接,代码如下: 如果你在共享空间中点击这个文本并重新打开一个窗口,代码是:

如何在html中注释代码

html中注释代码的方法:先修改文件名,完善代码;然后创建三个div层,并使用“”进行注释;最后刷新网页。本教程的运行环境:windows7系统,html5版本,DELLG3电脑。用于注释的 html 中的代码

jquery如何输出html代码

jquery输出html代码的方法:1、直接输出tag元素,代码为[varform1=""];2、 输出带有变量的标签元素,代码为[varcountry=....]。杰克

为什么html看不到php代码

html看不到php代码,因为所有的php代码都是在网站发送到浏览器之前在服务器上执行的,而浏览器接收到的一切都是php嵌入到html中的结果。本文运行环境:windows7系统,PHP7.第1版,DELLG3

如何善用博客或网站上的标签?

用于博客和 网站 的强大但未充分利用的工具之一是标记页面或博客文章。有效地使用标签并不容易。在这篇文章中,我将通过几个例子来说明如何使用标签来充分利用它们,以及需要注意的问题和一些高级策略。 查看全部

抓取网页数据(

网站优化之规范代码规范化换行的Html代码对一个网站)

网站优化的标准HTML代码

规范化的 Html 代码对于 网站 有很多好处,例如:易于修改、易于代码维护、代码量大

如何优化 HTML网站 代码

一个高质量的网站,网站代码的优化是非常重要的。对于一个好的SEO人来说,虽然不需要精通代码,但是一些简单的基本代码还是需要懂的。要想成为优秀的SEO人眼,需要有不断学习的精神。我们的网站 中的某个页面需要网站 代码优化。如果想看懂代码,可以给网站的添加附加值,有利于蜘蛛爬网

增长知识!网站哪些html代码需要针对seo进行优化?

关于seo,大部分人看到的界面都是用html代码组织的。优化网站html代码的目的是为了让网站更适合搜索引擎。精致的网站一端适合用户,另一端适合

git 拉取代码到本地

git拉码到本地的方法是:先打开git命令窗口,输入命令【gitclonegithub仓库地址】;然后回车拉码到本地仓库。第一步:拉取远程代码 gitclone

如何在html中直接显示html代码

本文文章将介绍在html中直接显示html代码的方式。有一定的参考价值,有需要的朋友可以参考,希望对大家有所帮助。百度做了很多实践,感觉很多都没有测试过就废话了。

如何编写html换行代码

html换行代码是“

",在要换行的行末尾,添加"

《代码可以实现换行操作.html》

”标签用于插入简单的换行符,实现换行。本教程运行环境:win

关于精简网站代码优化技巧

在网站的基础seo优化中,精简CSS代码和精简HTML代码是一项重要的优化技术。代码的简化直接影响到搜索引擎爬取网站的效果,因为搜索引擎爬取的第一步是网站的文章内容。严重影响搜索引擎抓取文章内容的效果。代码简化后,不仅可以增加网站的文字内容比例,还可以

关于精简网站代码优化技巧

在网站的基础seo优化中,精简CSS代码和精简HTML代码是一项重要的优化技术。代码的简化直接影响到搜索引擎爬取网站的效果,因为搜索引擎爬取的第一步是网站的文章内容。严重影响搜索引擎抓取文章内容的效果。代码简化后,不仅可以增加网站的文字内容比例,还可以

html中的空格代码是什么

HTML空格码就是HTML空格字符码,由“&+n+b+s+p+;”组成,记住最后一个分号不要忘记。在 CSS 中,当 white-space 属性的值为 pre 时,浏览器会在文本中保留空格和换行符,例如:

如何在vscode中运行html代码