scrapy分页抓取网页

谈谈对Python爬虫的理解

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-05-08 00:00

爬虫也可以称为Python爬虫

不知从何时起,Python这门语言和爬虫就像一对恋人,二者如胶似漆 ,形影不离,你中有我、我中有你

一提起爬虫,就会想到Python,一说起Python,就会想到人工智能……和爬虫

所以,一般说爬虫的时候,大部分程序员潜意识里都会联想为Python爬虫,为什么会这样,我觉得有两个原因:

任何一个学习Python的程序员,应该都或多或少地见过甚至研究过爬虫,我当时写Python的目的就非常纯粹——为了写爬虫

所以本文的目的很简单,就是说说我个人对Python爬虫的理解与实践,作为一名程序员,我觉得了解一下爬虫的相关知识对你只有好处,所以读完这篇文章后,如果能对你有帮助,那便再好不过

什么是爬虫

爬虫是一个程序,这个程序的目的就是为了抓取万维网信息资源,比如你日常使用的谷歌等搜索引擎,搜索结果就全都依赖爬虫来定时获取

看上述搜索结果,除了wiki相关介绍外,爬虫有关的搜索结果全都带上了Python,前人说Python爬虫,现在看来果然诚不欺我~

爬虫的目标对象也很丰富,不论是文字、图片、视频,任何结构化非结构化的数据爬虫都可以爬取,爬虫经过发展,也衍生出了各种爬虫类型:

不想说这些大方向的概念,让我们以一个获取网页内容为例,从爬虫技术本身出发,来说说网页爬虫,步骤如下:

什么是爬虫,这就是爬虫:

<p>"""让我们根据上面说的步骤来完成一个简单的爬虫程序"""

import requests

<br />

from bs4 import BeautifulSoup

<br />

target_url = 'http://www.baidu.com/s?wd=爬虫'

<br />

# 第一步 发起一个GET请求

res = requests.get(target_url)

<br />

# 第二步 提取HTML并解析想获取的数据 比如获取 title

soup = BeautifulSoup(res.text, "lxml")

# 输出 soup.title.text

title = soup.title.text

<br />

# 第三步 持久化 比如保存到本地

with open('title.txt', 'w') as fp:

fp.write(title)</p>

加上注释不到20行代码,你就完成了一个爬虫,简单吧

怎么写爬虫

网页世界多姿多彩、亿万网页资源供你选择,面对不同的页面,怎么使自己编写的爬虫程序够稳健、持久,这是一个值得讨论的问题

俗话说,磨刀不误砍柴工,在开始编写爬虫之前,很有必要掌握一些基本知识:

这两句描述体现了一名爬虫开发人员需要掌握的基本知识,不过一名基本的后端或者前端工程师都会这些哈哈,这也说明了爬虫的入门难度极低,从这两句话,你能思考出哪些爬虫必备的知识点呢?

有了这些知识储备,接下来就可以选择一门语言,开始编写自己的爬虫程序了,还是按照上一节说的三个步骤,然后以Python为例,说一说要在编程语言方面做那些准备:

掌握了上面这些,你大可放开手脚大干一场,万维网就是你的名利场,去吧~

我觉得对于一个目标网站的网页,可以分下面四个类型:

具体是什么意思呢,可能看起来有点绕,但明白这些,你之后写爬虫,只要在脑子里面过一遍着网页对应什么类型,然后套上对应类型的程序(写多了都应该有一套自己的常用代码库),那写爬虫的速度,自然不会慢

单页面单目标

通俗来说,就是在这个网页里面,我们的目标就只有一个,假设我们的需求是抓取这部电影-肖申克的救赎的名称,首先打开网页右键审查元素,找到电影名称对应的元素位置,如下图所示:

在某个单一页面内,看目标是不是只有一个,一眼就能看出标题的CSS Selector规则为:#content > h1 > span:nth-child(1),然后用我自己写的常用库,我用不到十行代码就能写完抓取这个页面电影名称的爬虫:

<p>import asyncio

<br />

from ruia import Item, TextField

<br />

class DoubanItem(Item):

title = TextField(css_select='#content > h1 > span:nth-child(1)')

<br />

async_func = DoubanItem.get_item(url="https://movie.douban.com/subject/1292052/")

item = asyncio.get_event_loop().run_until_complete(async_func)

print(item.title)</p>

多页面多目标就是此情况下多个url的衍生情况

单页面多目标

假设现在的需求是抓取豆瓣电影250第一页中的所有电影名称,你需要提取25个电影名称,因为这个目标页的目标数据是多个item的,因此目标需要循环获取,这就是所谓的单页面多目标了:

<p>import asyncio

<br />

from ruia import Item, TextField

<br />

class DoubanItem(Item):

target_item = TextField(css_select='div.item')

title = TextField(css_select='span.title')

<br />

async def clean_title(self, title):

if isinstance(title, str):

return title

else:

return ''.join([i.text.strip().replace('\xa0', '') for i in title])

<br />

<br />

async_func = DoubanItem.get_items(url="https://movie.douban.com/top250")

items = asyncio.get_event_loop().run_until_complete(async_func)

for item in items:

print(item)</p>

多页面多目标

多页面多目标是上述单页面多目标情况的衍生,在这个问题上来看,此时就是获取所有分页的电影名称

<p>from ruia import TextField, Item, Request, Spider

<br />

<br />

class DoubanItem(Item):

"""

定义爬虫的目标字段

"""

target_item = TextField(css_select='div.item')

title = TextField(css_select='span.title')

<br />

async def clean_title(self, title):

if isinstance(title, str):

return title

else:

return ''.join([i.text.strip().replace('\xa0', '') for i in title])

<br />

<br />

class DoubanSpider(Spider):

start_urls = ['https://movie.douban.com/top250']

concurrency = 10

<br />

async def parse(self, res):

etree = res.html_etree

pages = ['?start=0&filter='] + [i.get('href') for i in etree.cssselect('.paginator>a')]

<br />

for index, page in enumerate(pages):

url = self.start_urls[0] + page

yield Request(

url,

callback=self.parse_item,

metadata={'index': index},

request_config=self.request_config

)

<br />

async def parse_item(self, res):

items_data = await DoubanItem.get_items(html=res.html)

res_list = []

for item in items_data:

res_list.append(item.title)

return res_list

<br />

<br />

if __name__ == '__main__':

DoubanSpider.start()</p>

如果网络没问题的话,会得到如下输出:

注意爬虫运行时间,1s不到,这就是异步的魅力

用Python写爬虫,就是这么简单优雅,诸位,看着网页就思考下:

一个爬虫程序就成型了,顺便一提,爬虫这东西,可以说是防君子不防小人,robots.txt大部分网站都有(它的目的是告诉爬虫什么可以爬取什么不可以爬取,比如:),各位想怎么爬取,自己衡量

如何进阶

不要以为写好一个爬虫程序就可以出师了,此时还有更多的问题在前面等着你,你要含情脉脉地看着你的爬虫程序,问自己三个问题:

前两个关于人性的问题在此不做过多叙述,因此跳过,但你们如果作为爬虫工程师的话,切不可跳过

会被反爬虫干掉么?

最后关于反爬虫的问题才是你爬虫程序强壮与否的关键因素,什么是反爬虫?

当越来越多的爬虫在互联网上横冲直撞后,网页资源维护者为了防止自身数据被抓取,开始进行一系列的措施来使得自身数据不易被别的程序爬取,这些措施就是反爬虫

比如检测IP访问频率、资源访问速度、链接是否带有关键参数、验证码检测机器人、ajax混淆、js加密等等

对于目前市场上的反爬虫,爬虫工程师常有的反反爬虫方案是下面这样的:

爬虫工程师的进阶之路其实就是不断反反爬虫,可谓艰辛,但换个角度想也是乐趣所在

关于框架

爬虫有自己的编写流程和标准,有了标准,自然就有了框架,像Python这种生态强大的语言,框架自然是多不胜数,目前世面上用的比较多的有:

这里不过多介绍,框架只是工具,是一种提升效率的方式,看你选择

说明

任何事物都有两面性,爬虫自然也不例外,因此我送诸位一张图,关键时刻好好想想

往期推荐:

查看全部

谈谈对Python爬虫的理解

爬虫也可以称为Python爬虫

不知从何时起,Python这门语言和爬虫就像一对恋人,二者如胶似漆 ,形影不离,你中有我、我中有你

一提起爬虫,就会想到Python,一说起Python,就会想到人工智能……和爬虫

所以,一般说爬虫的时候,大部分程序员潜意识里都会联想为Python爬虫,为什么会这样,我觉得有两个原因:

任何一个学习Python的程序员,应该都或多或少地见过甚至研究过爬虫,我当时写Python的目的就非常纯粹——为了写爬虫

所以本文的目的很简单,就是说说我个人对Python爬虫的理解与实践,作为一名程序员,我觉得了解一下爬虫的相关知识对你只有好处,所以读完这篇文章后,如果能对你有帮助,那便再好不过

什么是爬虫

爬虫是一个程序,这个程序的目的就是为了抓取万维网信息资源,比如你日常使用的谷歌等搜索引擎,搜索结果就全都依赖爬虫来定时获取

看上述搜索结果,除了wiki相关介绍外,爬虫有关的搜索结果全都带上了Python,前人说Python爬虫,现在看来果然诚不欺我~

爬虫的目标对象也很丰富,不论是文字、图片、视频,任何结构化非结构化的数据爬虫都可以爬取,爬虫经过发展,也衍生出了各种爬虫类型:

不想说这些大方向的概念,让我们以一个获取网页内容为例,从爬虫技术本身出发,来说说网页爬虫,步骤如下:

什么是爬虫,这就是爬虫:

<p>"""让我们根据上面说的步骤来完成一个简单的爬虫程序"""

import requests

<br />

from bs4 import BeautifulSoup

<br />

target_url = 'http://www.baidu.com/s?wd=爬虫'

<br />

# 第一步 发起一个GET请求

res = requests.get(target_url)

<br />

# 第二步 提取HTML并解析想获取的数据 比如获取 title

soup = BeautifulSoup(res.text, "lxml")

# 输出 soup.title.text

title = soup.title.text

<br />

# 第三步 持久化 比如保存到本地

with open('title.txt', 'w') as fp:

fp.write(title)</p>

加上注释不到20行代码,你就完成了一个爬虫,简单吧

怎么写爬虫

网页世界多姿多彩、亿万网页资源供你选择,面对不同的页面,怎么使自己编写的爬虫程序够稳健、持久,这是一个值得讨论的问题

俗话说,磨刀不误砍柴工,在开始编写爬虫之前,很有必要掌握一些基本知识:

这两句描述体现了一名爬虫开发人员需要掌握的基本知识,不过一名基本的后端或者前端工程师都会这些哈哈,这也说明了爬虫的入门难度极低,从这两句话,你能思考出哪些爬虫必备的知识点呢?

有了这些知识储备,接下来就可以选择一门语言,开始编写自己的爬虫程序了,还是按照上一节说的三个步骤,然后以Python为例,说一说要在编程语言方面做那些准备:

掌握了上面这些,你大可放开手脚大干一场,万维网就是你的名利场,去吧~

我觉得对于一个目标网站的网页,可以分下面四个类型:

具体是什么意思呢,可能看起来有点绕,但明白这些,你之后写爬虫,只要在脑子里面过一遍着网页对应什么类型,然后套上对应类型的程序(写多了都应该有一套自己的常用代码库),那写爬虫的速度,自然不会慢

单页面单目标

通俗来说,就是在这个网页里面,我们的目标就只有一个,假设我们的需求是抓取这部电影-肖申克的救赎的名称,首先打开网页右键审查元素,找到电影名称对应的元素位置,如下图所示:

在某个单一页面内,看目标是不是只有一个,一眼就能看出标题的CSS Selector规则为:#content > h1 > span:nth-child(1),然后用我自己写的常用库,我用不到十行代码就能写完抓取这个页面电影名称的爬虫:

<p>import asyncio

<br />

from ruia import Item, TextField

<br />

class DoubanItem(Item):

title = TextField(css_select='#content > h1 > span:nth-child(1)')

<br />

async_func = DoubanItem.get_item(url="https://movie.douban.com/subject/1292052/";)

item = asyncio.get_event_loop().run_until_complete(async_func)

print(item.title)</p>

多页面多目标就是此情况下多个url的衍生情况

单页面多目标

假设现在的需求是抓取豆瓣电影250第一页中的所有电影名称,你需要提取25个电影名称,因为这个目标页的目标数据是多个item的,因此目标需要循环获取,这就是所谓的单页面多目标了:

<p>import asyncio

<br />

from ruia import Item, TextField

<br />

class DoubanItem(Item):

target_item = TextField(css_select='div.item')

title = TextField(css_select='span.title')

<br />

async def clean_title(self, title):

if isinstance(title, str):

return title

else:

return ''.join([i.text.strip().replace('\xa0', '') for i in title])

<br />

<br />

async_func = DoubanItem.get_items(url="https://movie.douban.com/top250";)

items = asyncio.get_event_loop().run_until_complete(async_func)

for item in items:

print(item)</p>

多页面多目标

多页面多目标是上述单页面多目标情况的衍生,在这个问题上来看,此时就是获取所有分页的电影名称

<p>from ruia import TextField, Item, Request, Spider

<br />

<br />

class DoubanItem(Item):

"""

定义爬虫的目标字段

"""

target_item = TextField(css_select='div.item')

title = TextField(css_select='span.title')

<br />

async def clean_title(self, title):

if isinstance(title, str):

return title

else:

return ''.join([i.text.strip().replace('\xa0', '') for i in title])

<br />

<br />

class DoubanSpider(Spider):

start_urls = ['https://movie.douban.com/top250']

concurrency = 10

<br />

async def parse(self, res):

etree = res.html_etree

pages = ['?start=0&filter='] + [i.get('href') for i in etree.cssselect('.paginator>a')]

<br />

for index, page in enumerate(pages):

url = self.start_urls[0] + page

yield Request(

url,

callback=self.parse_item,

metadata={'index': index},

request_config=self.request_config

)

<br />

async def parse_item(self, res):

items_data = await DoubanItem.get_items(html=res.html)

res_list = []

for item in items_data:

res_list.append(item.title)

return res_list

<br />

<br />

if __name__ == '__main__':

DoubanSpider.start()</p>

如果网络没问题的话,会得到如下输出:

注意爬虫运行时间,1s不到,这就是异步的魅力

用Python写爬虫,就是这么简单优雅,诸位,看着网页就思考下:

一个爬虫程序就成型了,顺便一提,爬虫这东西,可以说是防君子不防小人,robots.txt大部分网站都有(它的目的是告诉爬虫什么可以爬取什么不可以爬取,比如:),各位想怎么爬取,自己衡量

如何进阶

不要以为写好一个爬虫程序就可以出师了,此时还有更多的问题在前面等着你,你要含情脉脉地看着你的爬虫程序,问自己三个问题:

前两个关于人性的问题在此不做过多叙述,因此跳过,但你们如果作为爬虫工程师的话,切不可跳过

会被反爬虫干掉么?

最后关于反爬虫的问题才是你爬虫程序强壮与否的关键因素,什么是反爬虫?

当越来越多的爬虫在互联网上横冲直撞后,网页资源维护者为了防止自身数据被抓取,开始进行一系列的措施来使得自身数据不易被别的程序爬取,这些措施就是反爬虫

比如检测IP访问频率、资源访问速度、链接是否带有关键参数、验证码检测机器人、ajax混淆、js加密等等

对于目前市场上的反爬虫,爬虫工程师常有的反反爬虫方案是下面这样的:

爬虫工程师的进阶之路其实就是不断反反爬虫,可谓艰辛,但换个角度想也是乐趣所在

关于框架

爬虫有自己的编写流程和标准,有了标准,自然就有了框架,像Python这种生态强大的语言,框架自然是多不胜数,目前世面上用的比较多的有:

这里不过多介绍,框架只是工具,是一种提升效率的方式,看你选择

说明

任何事物都有两面性,爬虫自然也不例外,因此我送诸位一张图,关键时刻好好想想

往期推荐:

scrapy分页抓取网页 6000 多款 App,看我如何搞定她们并将其洗白白~

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-05-06 04:09

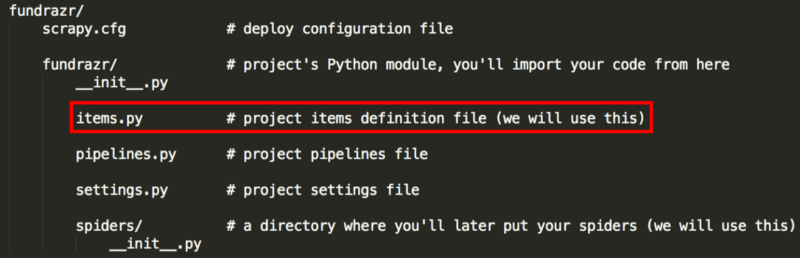

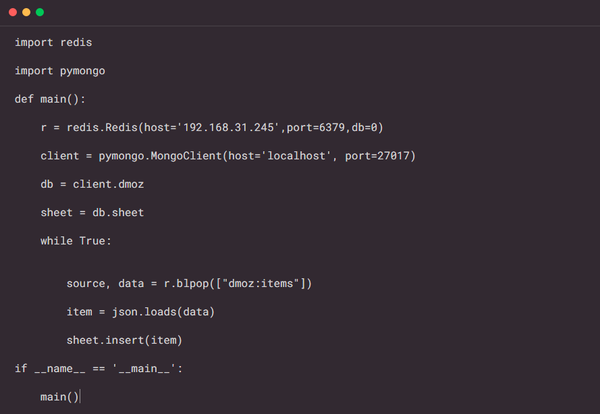

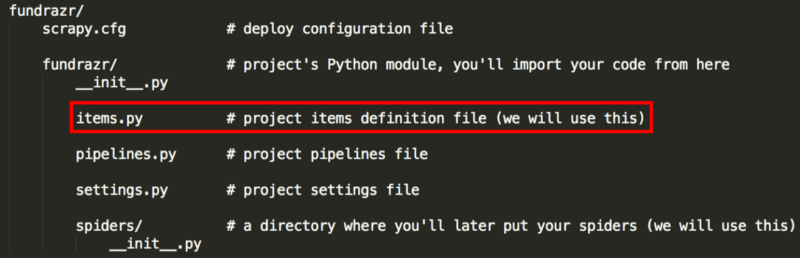

项目文件创建好以后,我们就可以开始写爬虫程序了。

首先,需要在 items.py 文件中,预先定义好要爬取的字段信息名称,如下所示:

1class KuanItem(scrapy.Item):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2# define the fields for your item here like:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3name = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4volume = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5download = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6follow = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7comment = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8tags = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9score = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10num_score = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这里的字段信息就是我们前面在网页中定位的 8 个字段信息,包括:name 表示 App 名称、volume 表示体积、download 表示下载数量。在这里定义好之后,我们在后续的爬取主程序中会利用到这些字段信息。

2.3.3. 爬取主程序

创建好 kuan 项目后,Scrapy 框架会自动生成爬取的部分代码,我们接下来就需要在 parse 方法中增加网页抓取的字段解析内容。

1class KuanspiderSpider(scrapy.Spider):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2 name = 'kuan'<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3 allowed_domains = ['www.coolapk.com']<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 start_urls = ['http://www.coolapk.com/']<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />6 def parse(self, response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />7 pass<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

打开主页 Dev Tools,找到每项抓取指标的节点位置,然后可以采用 CSS、Xpath、正则等方法进行提取解析,这些方法 Scrapy 都支持,可随意选择,这里我们选用 CSS 语法来定位节点,不过需要注意的是,Scrapy 的 CSS 语法和之前我们利用 pyquery 使用的 CSS 语法稍有不同,举几个例子,对比说明一下。

首先,我们定位到第一个 APP 的主页 URL 节点,可以看到 URL 节点位于 class 属性为app_left_list的 div 节点下的 a 节点中,其 href 属性就是我们需要的 URL 信息,这里是相对地址,拼接后就是完整的 URL。

接着我们进入酷安详情页,选择 App 名称并进行定位,可以看到 App 名称节点位于 class 属性为.detail_app_title的 p 节点的文本中。

定位到这两个节点之后,我们就可以使用 CSS 提取字段信息了,这里对比一下常规写法和 Scrapy 中的写法:

1# 常规写法<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2url = item('.app_left_list>a').attr('href')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3name = item('.list_app_title').text()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4# Scrapy 写法<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5url = item.css('::attr("href")').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />6name = item.css('.detail_app_title::text').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

可以看到,要获取 href 或者 text 属性,需要用 :: 表示,比如获取 text,则用 ::text。extract_first() 表示提取第一个元素,如果有多个元素,则用 extract() 。接着,我们就可以参照写出 8 个字段信息的解析代码。

首先,我们需要在主页提取 App 的 URL 列表,然后再进入每个 App 的详情页进一步提取 8 个字段信息。

1def parse(self, response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2 contents = response.css('.app_left_list>a')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3 for content in contents:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 url = content.css('::attr("href")').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5 url = response.urljoin(url) # 拼接相对 url 为绝对 url<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />6 yield scrapy.Request(url,callback=self.parse_url)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这里,利用 response.urljoin() 方法将提取出的相对 URL 拼接为完整的 URL,然后利用 scrapy.Request() 方法构造每个 App 详情页的请求,这里我们传递两个参数:url 和 callback,url 为详情页 URL,callback 是回调函数,它将主页 URL 请求返回的响应 response 传给专门用来解析字段内容的 parse_url() 方法,如下所示:

1def parse_url(self,response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2 item = KuanItem()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3 item['name'] = response.css('.detail_app_title::text').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4 results = self.get_comment(response)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5 item['volume'] = results[0]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6 item['download'] = results[1]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7 item['follow'] = results[2]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8 item['comment'] = results[3]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9 item['tags'] = self.get_tags(response)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10 item['score'] = response.css('.rank_num::text').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />11 num_score = response.css('.apk_rank_p1::text').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />12 item['num_score'] = re.search('共(.*?)个评分',num_score).group(1)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />13 yield item<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />14<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />15def get_comment(self,response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />16 messages = response.css('.apk_topba_message::text').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />17 result = re.findall(r'\s+(.*?)\s+/\s+(.*?)下载\s+/\s+(.*?)人关注\s+/\s+(.*?)个评论.*?',messages) # \s+ 表示匹配任意空白字符一次以上<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />18 if result: # 不为空<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />19 results = list(result[0]) # 提取出list 中第一个元素<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />20 return results<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />21<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />22def get_tags(self,response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />23 data = response.css('.apk_left_span2')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />24 tags = [item.css('::text').extract_first() for item in data]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />25 return tags<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这里,单独定义了 get_comment() 和 get_tags() 两个方法.

get_comment() 方法通过正则匹配提取 volume、download、follow、comment 四个字段信息,正则匹配结果如下:

1result = re.findall(r'\s+(.*?)\s+/\s+(.*?)下载\s+/\s+(.*?)人关注\s+/\s+(.*?)个评论.*?',messages)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2print(result) # 输出第一页的结果信息<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3# 结果如下:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4[('21.74M', '5218万', '2.4万', '5.4万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5[('75.53M', '2768万', '2.3万', '3.0万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6[('46.21M', '1686万', '2.3万', '3.4万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7[('54.77M', '1603万', '3.8万', '4.9万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8[('3.32M', '1530万', '1.5万', '3343')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9[('75.07M', '1127万', '1.6万', '2.2万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10[('92.70M', '1108万', '9167', '1.3万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />11[('68.94M', '1072万', '5718', '9869')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />12[('61.45M', '935万', '1.1万', '1.6万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />13[('23.96M', '925万', '4157', '1956')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

然后利用 result[0]、result[1] 等分别提取出四项信息,以 volume 为例,输出第一页的提取结果:

1item['volume'] = results[0]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2print(item['volume'])<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 321.74M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 475.53M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 546.21M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 654.77M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 73.32M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 875.07M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 992.70M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />1068.94M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />1161.45M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />1223.96M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这样一来,第一页 10 款 App 的所有字段信息都被成功提取出来,然后返回到 yied item 生成器中,我们输出一下它的内容:

1[<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2{'name': '酷安', 'volume': '21.74M', 'download': '5218万', 'follow': '2.4万', 'comment': '5.4万', 'tags': "['酷市场', '酷安', '市场', 'coolapk', '装机必备']", 'score': '4.4', 'num_score': '1.4万'}, <br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3{'name': '微信', 'volume': '75.53M', 'download': '2768万', 'follow': '2.3万', 'comment': '3.0万', 'tags': "['微信', 'qq', '腾讯', 'tencent', '即时聊天', '装机必备']",'score': '2.3', 'num_score': '1.1万'},<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4...<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

2.3.4. 分页爬取

以上,我们爬取了第一页内容,接下去需要遍历爬取全部 610 页的内容,这里有两种思路:

这里,我们分别写出两种方法的解析代码,第一种方法很简单,直接接着 parse 方法继续添加以下几行代码即可:

1def parse(self, response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2 contents = response.css('.app_left_list>a')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3 for content in contents:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 ...<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />6 next_page = response.css('.pagination li:nth-child(8) a::attr(href)').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />7 url = response.urljoin(next_page)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />8 yield scrapy.Request(url,callback=self.parse )<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

第二种方法,我们在最开头的 parse() 方法前,定义一个 start_requests() 方法,用来批量生成 610 页的 URL,然后通过 scrapy.Request() 方法中的 callback 参数,传递给下面的 parse() 方法进行解析。

1def start_requests(self):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2 pages = []<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3 for page in range(1,610): # 一共有610页<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 url = 'https://www.coolapk.com/apk/?page=%s'%page<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5 page = scrapy.Request(url,callback=self.parse)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />6 pages.append(page)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />7 return pages<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

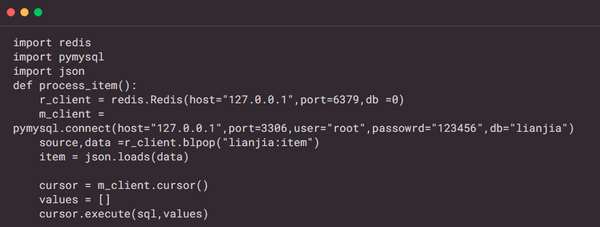

以上就是全部页面的爬取思路,爬取成功后,我们需要存储下来。这里,我面选择存储到 MongoDB 中,不得不说,相比 MySQL,MongoDB 要方便省事很多。

2.3.5. 存储结果

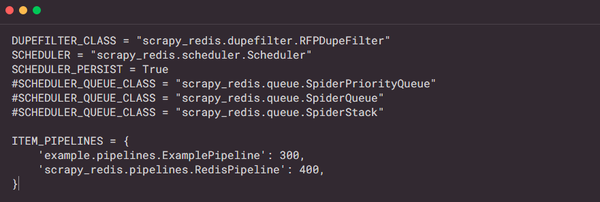

我们在 pipelines.py 程序中,定义数据存储方法,MongoDB 的一些参数,比如地址和数据库名称,需单独存放在 settings.py 设置文件中去,然后在 pipelines 程序中进行调用即可。

1import pymongo<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2class MongoPipeline(object):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3 def __init__(self,mongo_url,mongo_db):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4 self.mongo_url = mongo_url<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5 self.mongo_db = mongo_db<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6 @classmethod<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7 def from_crawler(cls,crawler):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8 return cls(<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9 mongo_url = crawler.settings.get('MONGO_URL'),<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10 mongo_db = crawler.settings.get('MONGO_DB')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />11 )<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />12 def open_spider(self,spider):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />13 self.client = pymongo.MongoClient(self.mongo_url)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />14 self.db = self.client[self.mongo_db]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />15 def process_item(self,item,spider):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />16 name = item.__class__.__name__<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />17 self.db[name].insert(dict(item))<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />18 return item<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />19 def close_spider(self,spider):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />20 self.client.close()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

首先,我们定义一个 MongoPipeline()存储类,里面定义了几个方法,简单进行一下说明:

from crawler() 是一个类方法,用 @class method 标识,这个方法的作用主要是用来获取我们在 settings.py 中设置的这几项参数:

1MONGO_URL = 'localhost'<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2MONGO_DB = 'KuAn'<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3ITEM_PIPELINES = {<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 'kuan.pipelines.MongoPipeline': 300,<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5}<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

open_spider() 方法主要进行一些初始化操作 ,在 Spider 开启时,这个方法就会被调用 。

process_item() 方法是最重要的方法,实现插入数据到 MongoDB 中。

完成上述代码以后,输入下面一行命令就可以开始整个爬虫的抓取和存储过程了,单机跑的话,6000 个网页需要不少时间才能完成,保持耐心。

1scrapy crawl kuan<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这里,还有两点补充:

第一,为了减轻网站压力,我们最好在每个请求之间设置几秒延时,可以在 KuanSpider() 方法开头出,加入以下几行代码:

1custom_settings = {<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2 "DOWNLOAD_DELAY": 3, # 延迟3s,默认是0,即不延迟<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3 "CONCURRENT_REQUESTS_PER_DOMAIN": 8 # 每秒默认并发8次,可适当降低<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 }<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

第二,为了更好监控爬虫程序运行,有必要设置输出日志文件,可以通过 Python 自带的 logging 包实现:

1import logging<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3logging.basicConfig(filename='kuan.log',filemode='w',level=logging.WARNING,format='%(asctime)s %(message)s',datefmt='%Y/%m/%d %I:%M:%S %p')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4logging.warning("warn message")<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5logging.error("error message")<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这里的 level 参数表示警告级别,严重程度从低到高分别是:DEBUG < INFO < WARNING < ERROR < CRITICAL,如果想日志文件不要记录太多内容,可以设置高一点的级别,这里设置为 WARNING,意味着只有 WARNING 级别以上的信息才会输出到日志中去。

添加 datefmt 参数是为了在每条日志前面加具体的时间,这点很有用处。

以上,我们就完成了整个数据的抓取,有了数据我们就可以着手进行分析,不过这之前还需简单地对数据做一下清洗和处理。

3. 数据清洗处理

首先,我们从 MongoDB 中读取数据并转化为 DataFrame,然后查看一下数据的基本情况。

1def parse_kuan():<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2 client = pymongo.MongoClient(host='localhost', port=27017)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3 db = client['KuAn']<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4 collection = db['KuAnItem']<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5 # 将数据库数据转为DataFrame<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6 data = pd.DataFrame(list(collection.find()))<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7 print(data.head())<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8 print(df.shape)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9 print(df.info())<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10 print(df.describe())<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

从 data.head() 输出的前 5 行数据中可以看到,除了 score 列是 float 格式以外,其他列都是 object 文本类型。

comment、download、follow、num_score 这 5 列数据中部分行带有「万」字后缀,需要将字符去掉再转换为数值型;volume 体积列,则分别带有「M」和「K」后缀,为了统一大小,则需将「K」除以 1024,转换为 「M」体积。

整个数据一共有 6086 行 x 8 列,每列均没有缺失值。

df.describe() 方法对 score 列做了基本统计,可以看到,所有 App 的平均得分是 3.9 分(5 分制),最低得分 1.6 分,最高得分 4.8 分。

下面,我们将以上几列文本型数据转换为数值型数据,代码实现如下:

1def data_processing(df):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2#处理'comment','download','follow','num_score','volume' 5列数据,将单位万转换为单位1,再转换为数值型<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3 str = '_ori'<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4 cols = ['comment','download','follow','num_score','volume']<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5 for col in cols:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6 colori = col+str<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7 df[colori] = df[col] # 复制保留原始列<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8 if not (col == 'volume'):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9 df[col] = clean_symbol(df,col)# 处理原始列生成新列<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10 else:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />11 df[col] = clean_symbol2(df,col)# 处理原始列生成新列<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />12<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />13 # 将download单独转换为万单位<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />14 df['download'] = df['download'].apply(lambda x:x/10000)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />15 # 批量转为数值型<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />16 df = df.apply(pd.to_numeric,errors='ignore')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />17<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />18def clean_symbol(df,col):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />19 # 将字符“万”替换为空<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />20 con = df[col].str.contains('万$')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />21 df.loc[con,col] = pd.to_numeric(df.loc[con,col].str.replace('万','')) * 10000<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />22 df[col] = pd.to_numeric(df[col])<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />23 return df[col]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />24<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />25def clean_symbol2(df,col):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />26 # 字符M替换为空<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />27 df[col] = df[col].str.replace('M$','')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />28 # 体积为K的除以 1024 转换为M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />29 con = df[col].str.contains('K$')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />30 df.loc[con,col] = pd.to_numeric(df.loc[con,col].str.replace('K$',''))/1024<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />31 df[col] = pd.to_numeric(df[col])<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />32 return df[col]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

以上,就完成了几列文本型数据的转换,我们再来查看一下基本情况:

download 列为 App 下载数量,下载量最多的 App 有 5190 万次,最少的为 0 (很少很少),平均下载次数为 14 万次;从中可以看出以下几点信息:

以上,就完成了基本的数据清洗处理过程,下一期将对这6000多款App进行探索性分析,看看有多少佳软神器你没有使用过哦。 查看全部

scrapy分页抓取网页 6000 多款 App,看我如何搞定她们并将其洗白白~

项目文件创建好以后,我们就可以开始写爬虫程序了。

首先,需要在 items.py 文件中,预先定义好要爬取的字段信息名称,如下所示:

1class KuanItem(scrapy.Item):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2# define the fields for your item here like:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3name = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4volume = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5download = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6follow = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7comment = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8tags = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9score = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10num_score = scrapy.Field()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这里的字段信息就是我们前面在网页中定位的 8 个字段信息,包括:name 表示 App 名称、volume 表示体积、download 表示下载数量。在这里定义好之后,我们在后续的爬取主程序中会利用到这些字段信息。

2.3.3. 爬取主程序

创建好 kuan 项目后,Scrapy 框架会自动生成爬取的部分代码,我们接下来就需要在 parse 方法中增加网页抓取的字段解析内容。

1class KuanspiderSpider(scrapy.Spider):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2 name = 'kuan'<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3 allowed_domains = ['www.coolapk.com']<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 start_urls = ['http://www.coolapk.com/']<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />6 def parse(self, response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />7 pass<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

打开主页 Dev Tools,找到每项抓取指标的节点位置,然后可以采用 CSS、Xpath、正则等方法进行提取解析,这些方法 Scrapy 都支持,可随意选择,这里我们选用 CSS 语法来定位节点,不过需要注意的是,Scrapy 的 CSS 语法和之前我们利用 pyquery 使用的 CSS 语法稍有不同,举几个例子,对比说明一下。

首先,我们定位到第一个 APP 的主页 URL 节点,可以看到 URL 节点位于 class 属性为app_left_list的 div 节点下的 a 节点中,其 href 属性就是我们需要的 URL 信息,这里是相对地址,拼接后就是完整的 URL。

接着我们进入酷安详情页,选择 App 名称并进行定位,可以看到 App 名称节点位于 class 属性为.detail_app_title的 p 节点的文本中。

定位到这两个节点之后,我们就可以使用 CSS 提取字段信息了,这里对比一下常规写法和 Scrapy 中的写法:

1# 常规写法<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2url = item('.app_left_list>a').attr('href')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3name = item('.list_app_title').text()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4# Scrapy 写法<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5url = item.css('::attr("href")').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />6name = item.css('.detail_app_title::text').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

可以看到,要获取 href 或者 text 属性,需要用 :: 表示,比如获取 text,则用 ::text。extract_first() 表示提取第一个元素,如果有多个元素,则用 extract() 。接着,我们就可以参照写出 8 个字段信息的解析代码。

首先,我们需要在主页提取 App 的 URL 列表,然后再进入每个 App 的详情页进一步提取 8 个字段信息。

1def parse(self, response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2 contents = response.css('.app_left_list>a')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3 for content in contents:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 url = content.css('::attr("href")').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5 url = response.urljoin(url) # 拼接相对 url 为绝对 url<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />6 yield scrapy.Request(url,callback=self.parse_url)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这里,利用 response.urljoin() 方法将提取出的相对 URL 拼接为完整的 URL,然后利用 scrapy.Request() 方法构造每个 App 详情页的请求,这里我们传递两个参数:url 和 callback,url 为详情页 URL,callback 是回调函数,它将主页 URL 请求返回的响应 response 传给专门用来解析字段内容的 parse_url() 方法,如下所示:

1def parse_url(self,response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2 item = KuanItem()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3 item['name'] = response.css('.detail_app_title::text').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4 results = self.get_comment(response)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5 item['volume'] = results[0]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6 item['download'] = results[1]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7 item['follow'] = results[2]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8 item['comment'] = results[3]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9 item['tags'] = self.get_tags(response)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10 item['score'] = response.css('.rank_num::text').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />11 num_score = response.css('.apk_rank_p1::text').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />12 item['num_score'] = re.search('共(.*?)个评分',num_score).group(1)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />13 yield item<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />14<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />15def get_comment(self,response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />16 messages = response.css('.apk_topba_message::text').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />17 result = re.findall(r'\s+(.*?)\s+/\s+(.*?)下载\s+/\s+(.*?)人关注\s+/\s+(.*?)个评论.*?',messages) # \s+ 表示匹配任意空白字符一次以上<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />18 if result: # 不为空<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />19 results = list(result[0]) # 提取出list 中第一个元素<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />20 return results<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />21<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />22def get_tags(self,response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />23 data = response.css('.apk_left_span2')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />24 tags = [item.css('::text').extract_first() for item in data]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />25 return tags<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这里,单独定义了 get_comment() 和 get_tags() 两个方法.

get_comment() 方法通过正则匹配提取 volume、download、follow、comment 四个字段信息,正则匹配结果如下:

1result = re.findall(r'\s+(.*?)\s+/\s+(.*?)下载\s+/\s+(.*?)人关注\s+/\s+(.*?)个评论.*?',messages)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2print(result) # 输出第一页的结果信息<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3# 结果如下:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4[('21.74M', '5218万', '2.4万', '5.4万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5[('75.53M', '2768万', '2.3万', '3.0万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6[('46.21M', '1686万', '2.3万', '3.4万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7[('54.77M', '1603万', '3.8万', '4.9万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8[('3.32M', '1530万', '1.5万', '3343')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9[('75.07M', '1127万', '1.6万', '2.2万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10[('92.70M', '1108万', '9167', '1.3万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />11[('68.94M', '1072万', '5718', '9869')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />12[('61.45M', '935万', '1.1万', '1.6万')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />13[('23.96M', '925万', '4157', '1956')]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

然后利用 result[0]、result[1] 等分别提取出四项信息,以 volume 为例,输出第一页的提取结果:

1item['volume'] = results[0]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2print(item['volume'])<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 321.74M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 475.53M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 546.21M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 654.77M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 73.32M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 875.07M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 992.70M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />1068.94M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />1161.45M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />1223.96M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这样一来,第一页 10 款 App 的所有字段信息都被成功提取出来,然后返回到 yied item 生成器中,我们输出一下它的内容:

1[<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2{'name': '酷安', 'volume': '21.74M', 'download': '5218万', 'follow': '2.4万', 'comment': '5.4万', 'tags': "['酷市场', '酷安', '市场', 'coolapk', '装机必备']", 'score': '4.4', 'num_score': '1.4万'}, <br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3{'name': '微信', 'volume': '75.53M', 'download': '2768万', 'follow': '2.3万', 'comment': '3.0万', 'tags': "['微信', 'qq', '腾讯', 'tencent', '即时聊天', '装机必备']",'score': '2.3', 'num_score': '1.1万'},<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4...<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

2.3.4. 分页爬取

以上,我们爬取了第一页内容,接下去需要遍历爬取全部 610 页的内容,这里有两种思路:

这里,我们分别写出两种方法的解析代码,第一种方法很简单,直接接着 parse 方法继续添加以下几行代码即可:

1def parse(self, response):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2 contents = response.css('.app_left_list>a')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3 for content in contents:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 ...<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />6 next_page = response.css('.pagination li:nth-child(8) a::attr(href)').extract_first()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />7 url = response.urljoin(next_page)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />8 yield scrapy.Request(url,callback=self.parse )<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

第二种方法,我们在最开头的 parse() 方法前,定义一个 start_requests() 方法,用来批量生成 610 页的 URL,然后通过 scrapy.Request() 方法中的 callback 参数,传递给下面的 parse() 方法进行解析。

1def start_requests(self):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2 pages = []<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3 for page in range(1,610): # 一共有610页<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 url = 'https://www.coolapk.com/apk/?page=%s'%page<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5 page = scrapy.Request(url,callback=self.parse)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />6 pages.append(page)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />7 return pages<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

以上就是全部页面的爬取思路,爬取成功后,我们需要存储下来。这里,我面选择存储到 MongoDB 中,不得不说,相比 MySQL,MongoDB 要方便省事很多。

2.3.5. 存储结果

我们在 pipelines.py 程序中,定义数据存储方法,MongoDB 的一些参数,比如地址和数据库名称,需单独存放在 settings.py 设置文件中去,然后在 pipelines 程序中进行调用即可。

1import pymongo<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2class MongoPipeline(object):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3 def __init__(self,mongo_url,mongo_db):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4 self.mongo_url = mongo_url<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5 self.mongo_db = mongo_db<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6 @classmethod<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7 def from_crawler(cls,crawler):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8 return cls(<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9 mongo_url = crawler.settings.get('MONGO_URL'),<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10 mongo_db = crawler.settings.get('MONGO_DB')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />11 )<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />12 def open_spider(self,spider):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />13 self.client = pymongo.MongoClient(self.mongo_url)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />14 self.db = self.client[self.mongo_db]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />15 def process_item(self,item,spider):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />16 name = item.__class__.__name__<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />17 self.db[name].insert(dict(item))<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />18 return item<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />19 def close_spider(self,spider):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />20 self.client.close()<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

首先,我们定义一个 MongoPipeline()存储类,里面定义了几个方法,简单进行一下说明:

from crawler() 是一个类方法,用 @class method 标识,这个方法的作用主要是用来获取我们在 settings.py 中设置的这几项参数:

1MONGO_URL = 'localhost'<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2MONGO_DB = 'KuAn'<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3ITEM_PIPELINES = {<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 'kuan.pipelines.MongoPipeline': 300,<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5}<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

open_spider() 方法主要进行一些初始化操作 ,在 Spider 开启时,这个方法就会被调用 。

process_item() 方法是最重要的方法,实现插入数据到 MongoDB 中。

完成上述代码以后,输入下面一行命令就可以开始整个爬虫的抓取和存储过程了,单机跑的话,6000 个网页需要不少时间才能完成,保持耐心。

1scrapy crawl kuan<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这里,还有两点补充:

第一,为了减轻网站压力,我们最好在每个请求之间设置几秒延时,可以在 KuanSpider() 方法开头出,加入以下几行代码:

1custom_settings = {<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2 "DOWNLOAD_DELAY": 3, # 延迟3s,默认是0,即不延迟<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3 "CONCURRENT_REQUESTS_PER_DOMAIN": 8 # 每秒默认并发8次,可适当降低<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4 }<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

第二,为了更好监控爬虫程序运行,有必要设置输出日志文件,可以通过 Python 自带的 logging 包实现:

1import logging<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />2<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />3logging.basicConfig(filename='kuan.log',filemode='w',level=logging.WARNING,format='%(asctime)s %(message)s',datefmt='%Y/%m/%d %I:%M:%S %p')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />4logging.warning("warn message")<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />5logging.error("error message")<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

这里的 level 参数表示警告级别,严重程度从低到高分别是:DEBUG < INFO < WARNING < ERROR < CRITICAL,如果想日志文件不要记录太多内容,可以设置高一点的级别,这里设置为 WARNING,意味着只有 WARNING 级别以上的信息才会输出到日志中去。

添加 datefmt 参数是为了在每条日志前面加具体的时间,这点很有用处。

以上,我们就完成了整个数据的抓取,有了数据我们就可以着手进行分析,不过这之前还需简单地对数据做一下清洗和处理。

3. 数据清洗处理

首先,我们从 MongoDB 中读取数据并转化为 DataFrame,然后查看一下数据的基本情况。

1def parse_kuan():<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2 client = pymongo.MongoClient(host='localhost', port=27017)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3 db = client['KuAn']<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4 collection = db['KuAnItem']<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5 # 将数据库数据转为DataFrame<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6 data = pd.DataFrame(list(collection.find()))<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7 print(data.head())<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8 print(df.shape)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9 print(df.info())<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10 print(df.describe())<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

从 data.head() 输出的前 5 行数据中可以看到,除了 score 列是 float 格式以外,其他列都是 object 文本类型。

comment、download、follow、num_score 这 5 列数据中部分行带有「万」字后缀,需要将字符去掉再转换为数值型;volume 体积列,则分别带有「M」和「K」后缀,为了统一大小,则需将「K」除以 1024,转换为 「M」体积。

整个数据一共有 6086 行 x 8 列,每列均没有缺失值。

df.describe() 方法对 score 列做了基本统计,可以看到,所有 App 的平均得分是 3.9 分(5 分制),最低得分 1.6 分,最高得分 4.8 分。

下面,我们将以上几列文本型数据转换为数值型数据,代码实现如下:

1def data_processing(df):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 2#处理'comment','download','follow','num_score','volume' 5列数据,将单位万转换为单位1,再转换为数值型<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 3 str = '_ori'<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 4 cols = ['comment','download','follow','num_score','volume']<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 5 for col in cols:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 6 colori = col+str<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 7 df[colori] = df[col] # 复制保留原始列<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 8 if not (col == 'volume'):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" /> 9 df[col] = clean_symbol(df,col)# 处理原始列生成新列<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />10 else:<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />11 df[col] = clean_symbol2(df,col)# 处理原始列生成新列<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />12<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />13 # 将download单独转换为万单位<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />14 df['download'] = df['download'].apply(lambda x:x/10000)<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />15 # 批量转为数值型<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />16 df = df.apply(pd.to_numeric,errors='ignore')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />17<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />18def clean_symbol(df,col):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />19 # 将字符“万”替换为空<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />20 con = df[col].str.contains('万$')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />21 df.loc[con,col] = pd.to_numeric(df.loc[con,col].str.replace('万','')) * 10000<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />22 df[col] = pd.to_numeric(df[col])<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />23 return df[col]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />24<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />25def clean_symbol2(df,col):<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />26 # 字符M替换为空<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />27 df[col] = df[col].str.replace('M$','')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />28 # 体积为K的除以 1024 转换为M<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />29 con = df[col].str.contains('K$')<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />30 df.loc[con,col] = pd.to_numeric(df.loc[con,col].str.replace('K$',''))/1024<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />31 df[col] = pd.to_numeric(df[col])<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />32 return df[col]<br style="max-width: 100%;box-sizing: border-box !important;overflow-wrap: break-word !important;" />

以上,就完成了几列文本型数据的转换,我们再来查看一下基本情况:

download 列为 App 下载数量,下载量最多的 App 有 5190 万次,最少的为 0 (很少很少),平均下载次数为 14 万次;从中可以看出以下几点信息:

以上,就完成了基本的数据清洗处理过程,下一期将对这6000多款App进行探索性分析,看看有多少佳软神器你没有使用过哦。

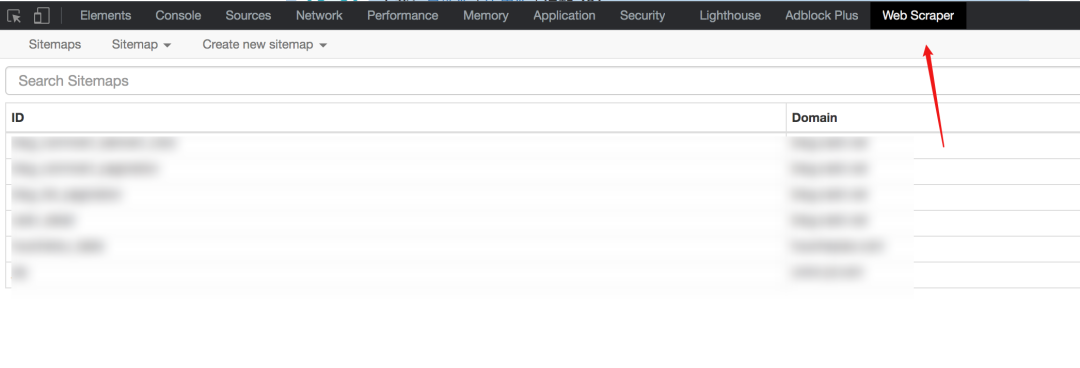

scrapy分页抓取网页(不重载页面的页面器爬取点入(1)_社会万象_光明网(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-04-20 13:36

一种是:点击下一页,只会重新渲染当前页面的一部分

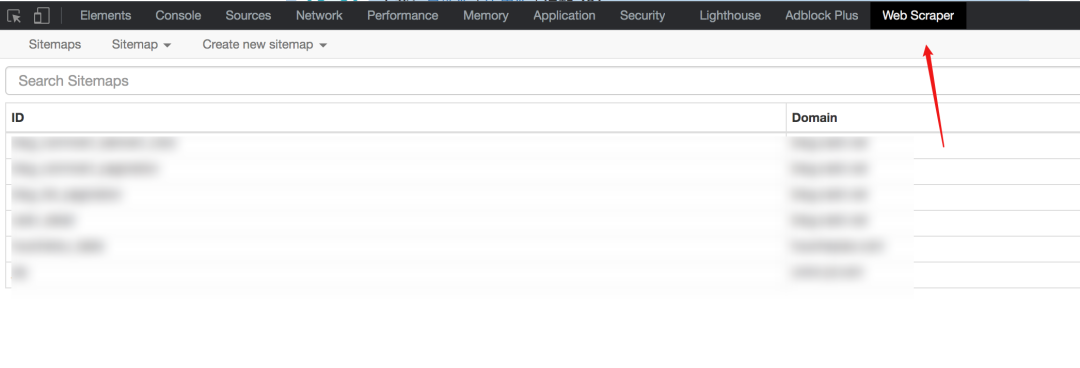

在早期版本的 web-scraper 中,两种抓取方式是不同的。

需要重新加载的页面需要链接选择器

如果不需要重新加载页面,可以使用元素点击选择器

对于某些 网站 可以,但有很大的限制。

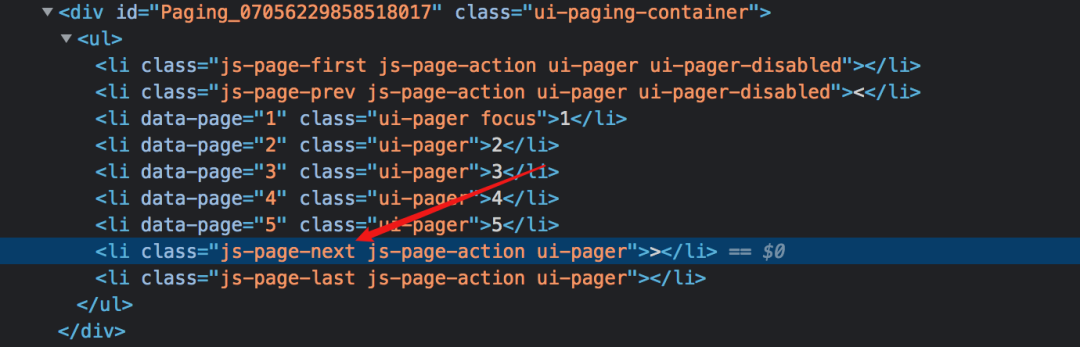

经过我的实验,使用Link选择器的第一个原理是取出下一页的a标签的超链接,然后去访问,但是并不是所有的网站的下一页都通过一个标签实现。

如果你使用js监听事件并像下面这样跳转,就不能使用Link选择器了。

新版网络爬虫特别支持导航分页器,并增加了分页选择器,可以完全适用于两种场景。下面我分别演示一下。

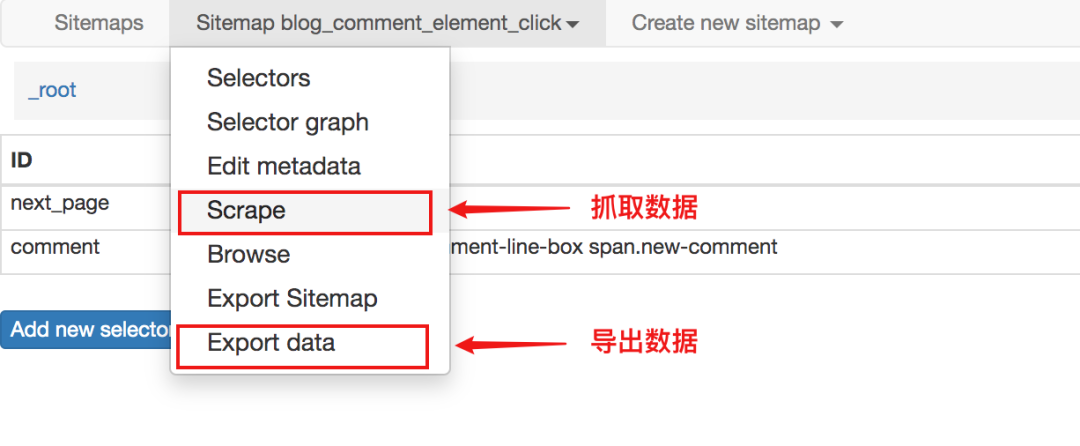

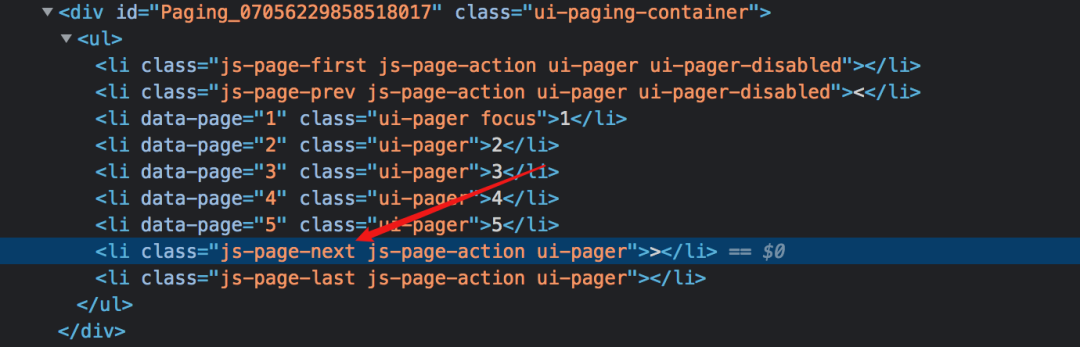

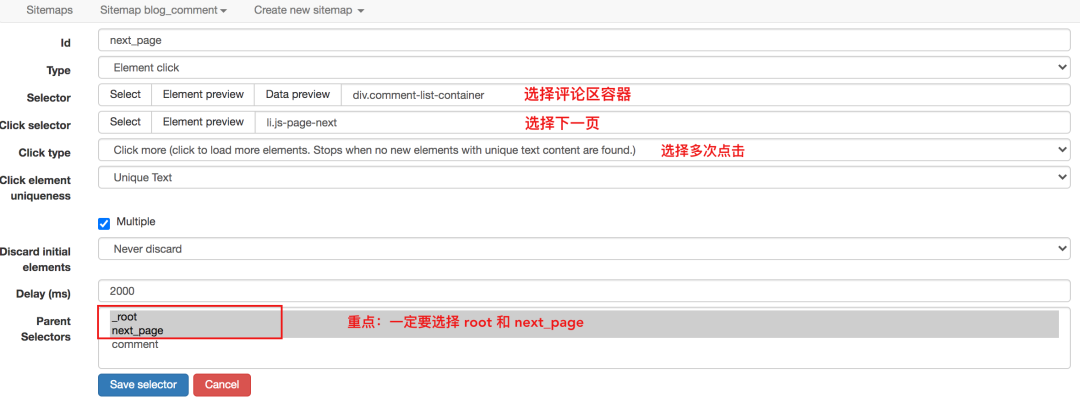

无需重新加载页面的分页器抓取

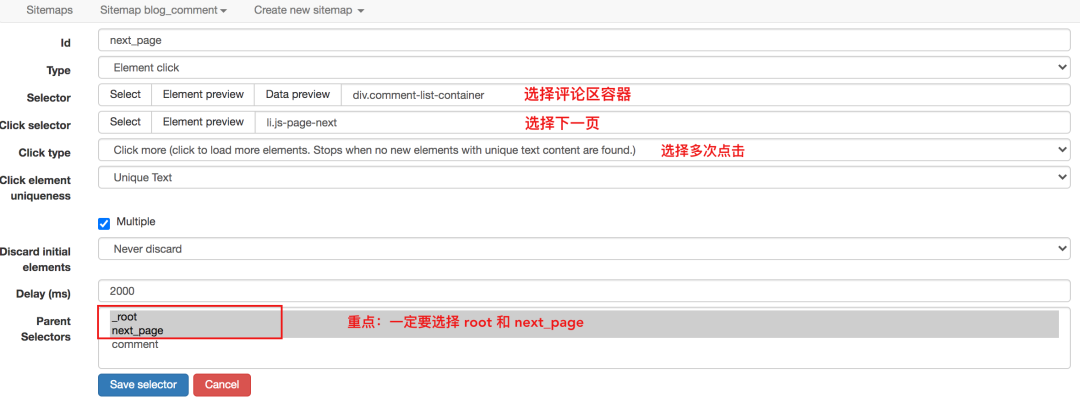

点击具体的CSDN博文,拉到底部查看评论区。

如果你的文章比较热门,有很多同学评论,CSDN会分页显示,但是不管在哪个页面,评论都属于同一篇文章文章,当您浏览任何页面的评论部分时,无需刷新博文,因为这种分页不会重新加载页面。

对于这种不需要重新加载页面的点击,可以使用Element Click来解决。

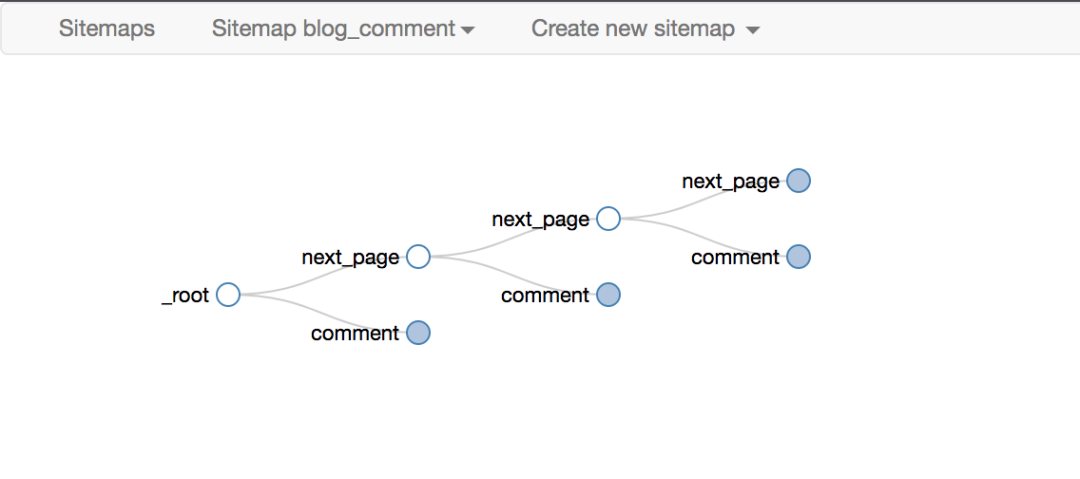

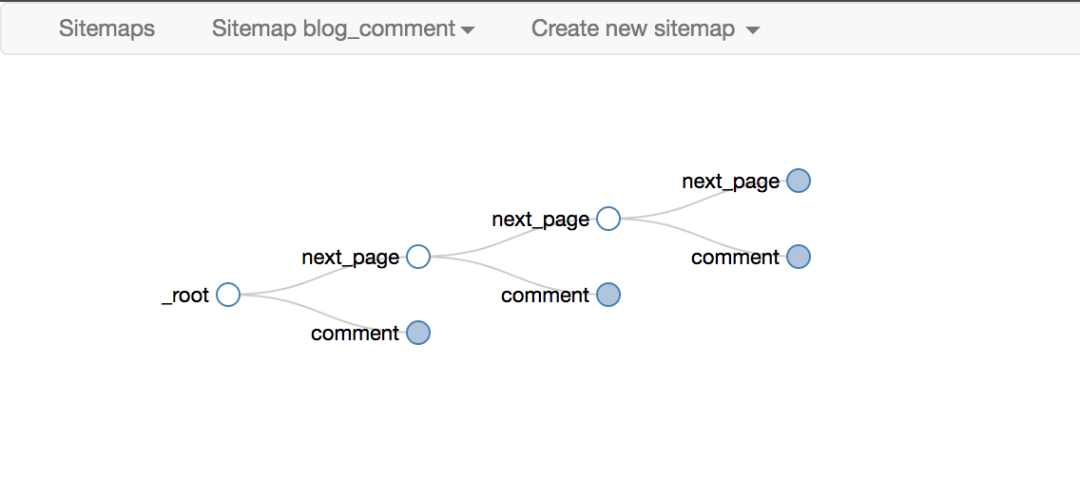

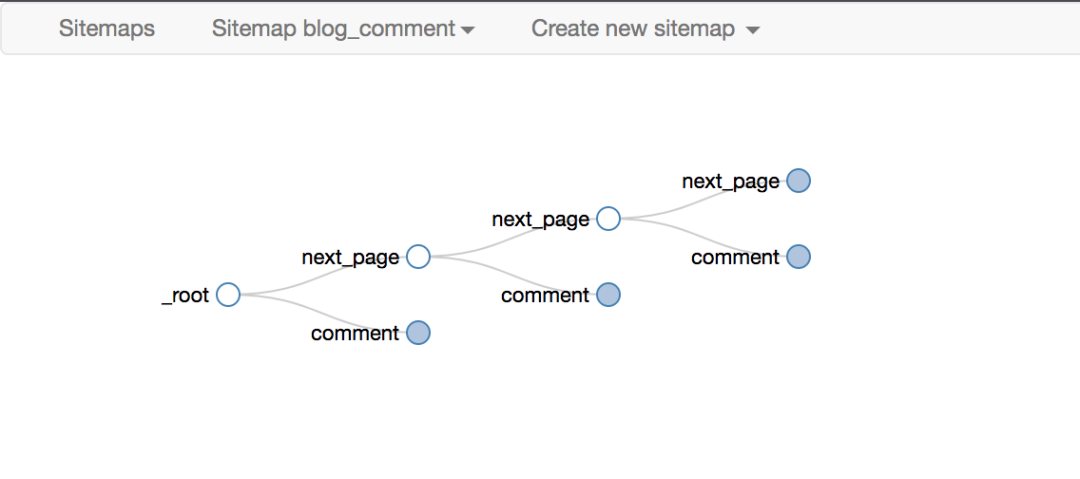

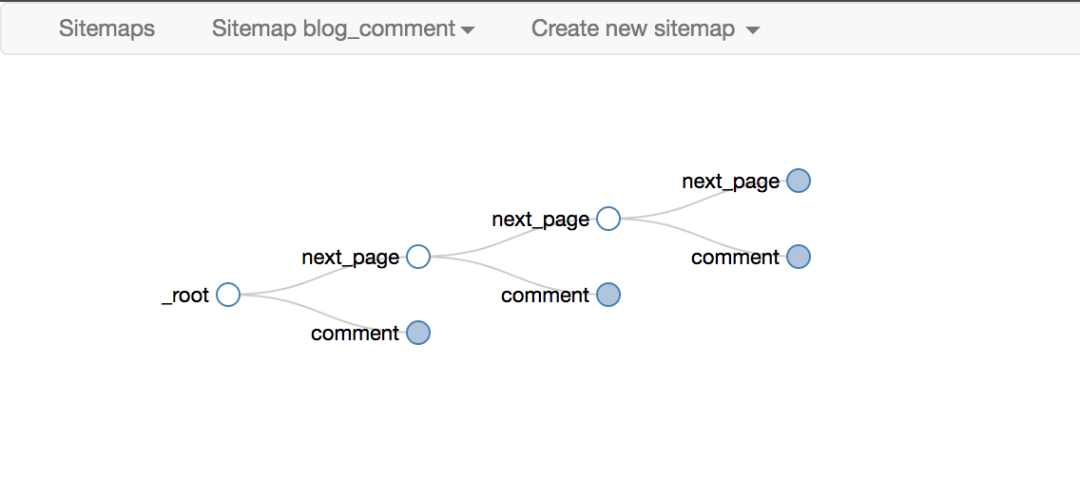

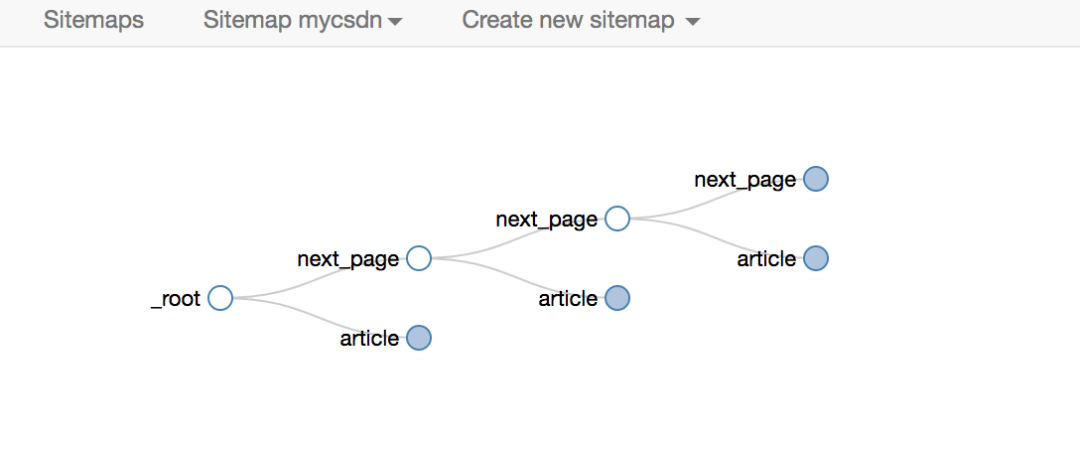

最后一点要注意root和next_page的选择,只有这样才能递归爬取

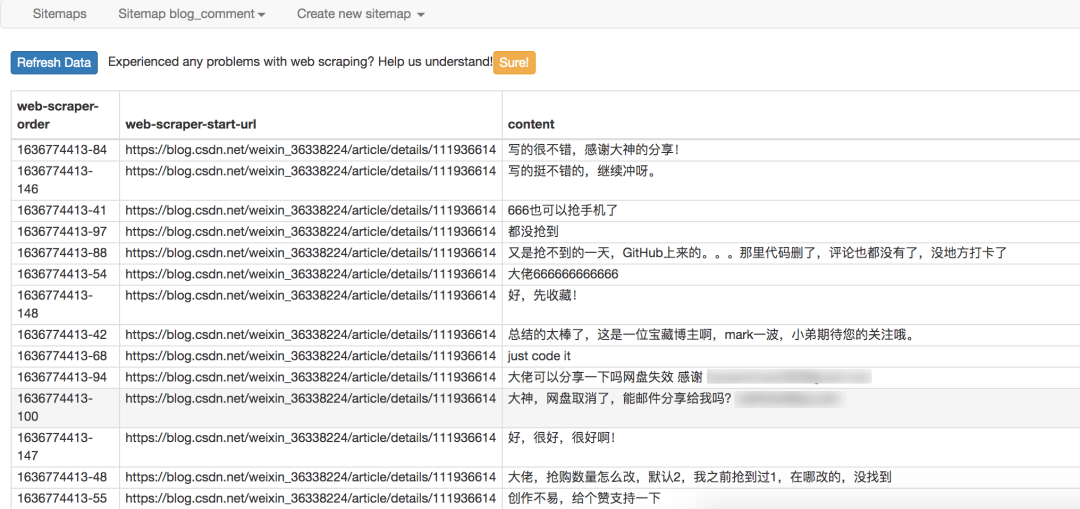

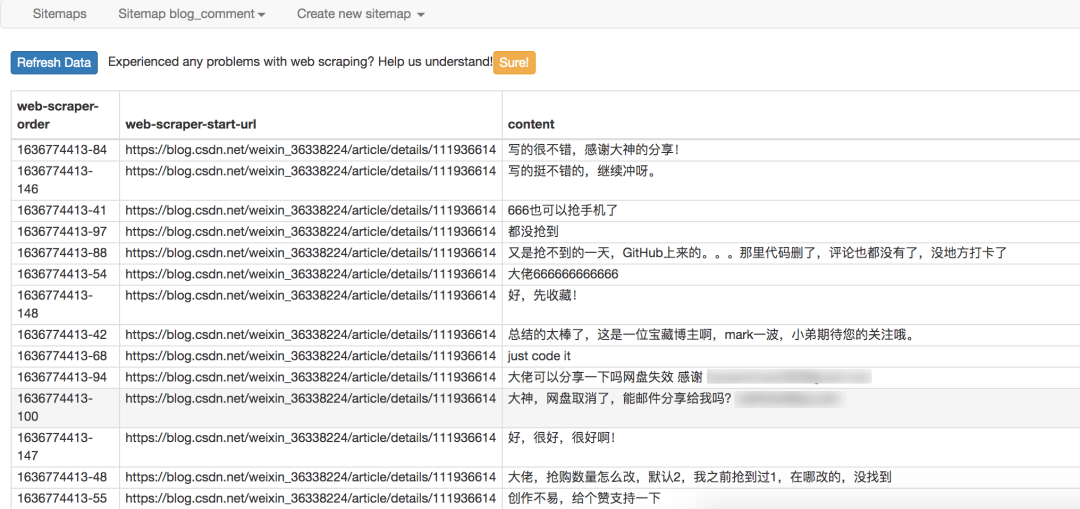

最终爬取效果如下

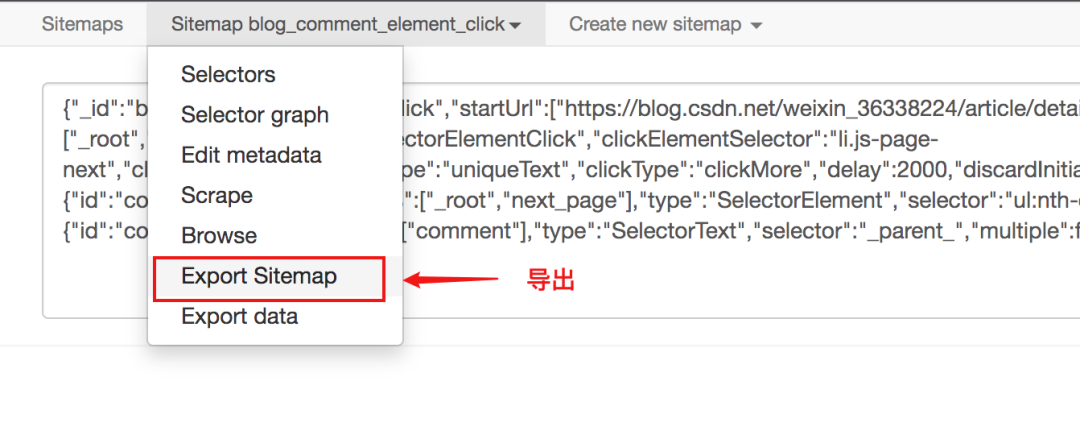

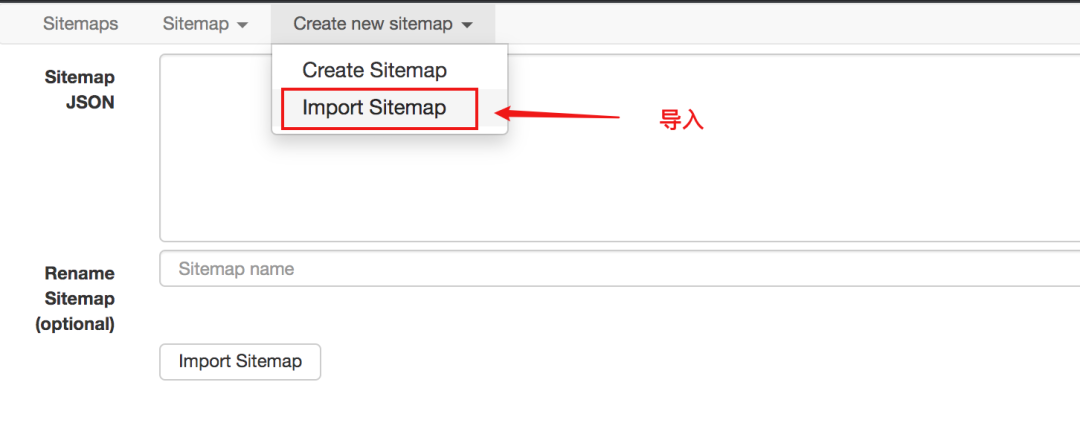

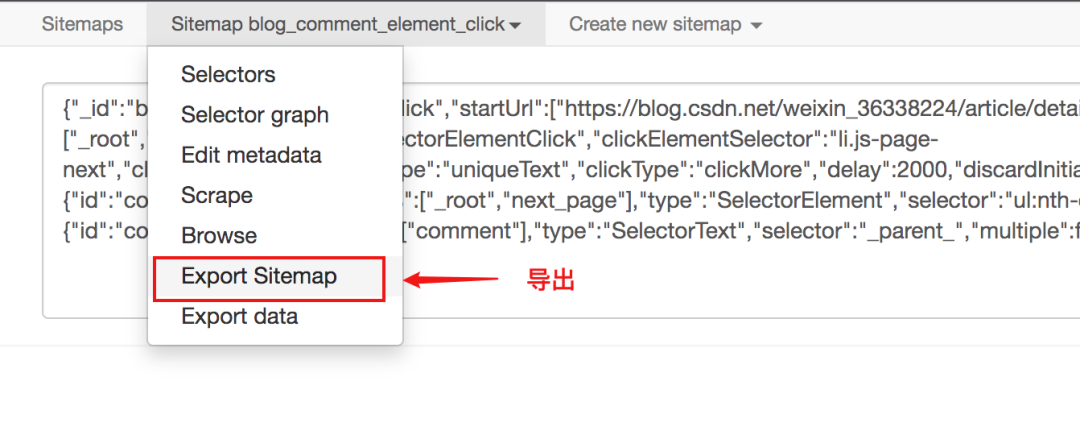

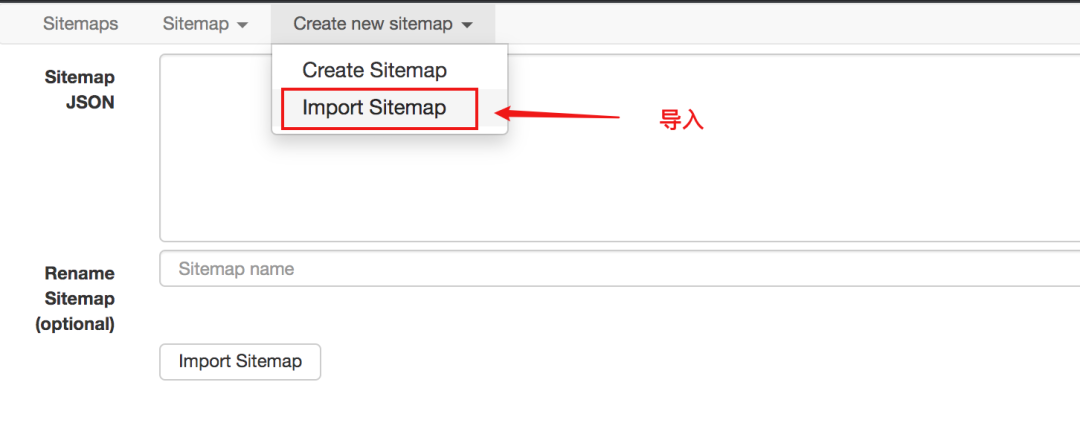

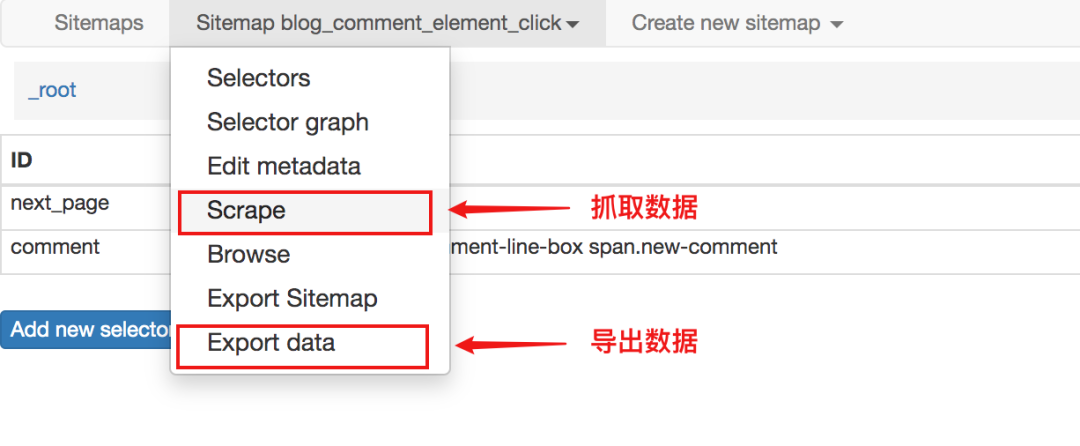

使用Element Click的站点地图配置如下,可以直接导入我的配置进行研究,下载配置文件:

当然,对于分页之类的东西,网络爬虫提供了更专业的分页选择器,更精简,效果最好

对应sitemap的配置如下,可以直接导入使用,下载配置文件:

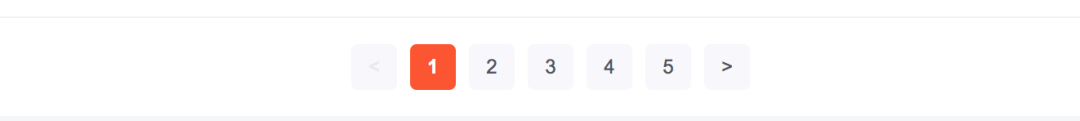

寻呼机抓取以重新加载页面

CSDN博客文章列表,拉到底部,点击具体页面按钮,否则最右边的下一页会重新加载当前页面。

对于这种分页器,Element Click什么都做不了,读者可以自行验证,最多爬一页后就关闭了。

而作为分页选择器的分页自然适用

爬取的拓扑同上,这里不再赘述。

对应sitemap的配置如下,可以直接导入学习,下载配置文件:

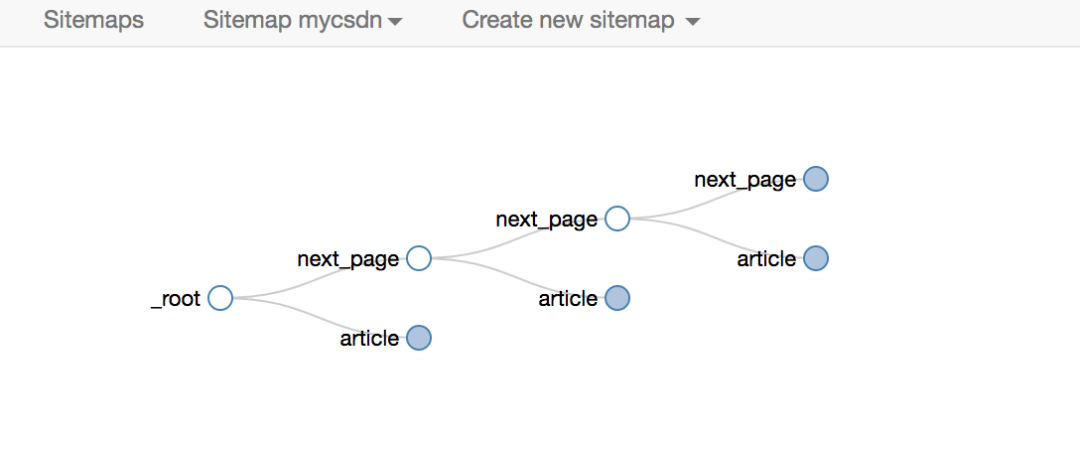

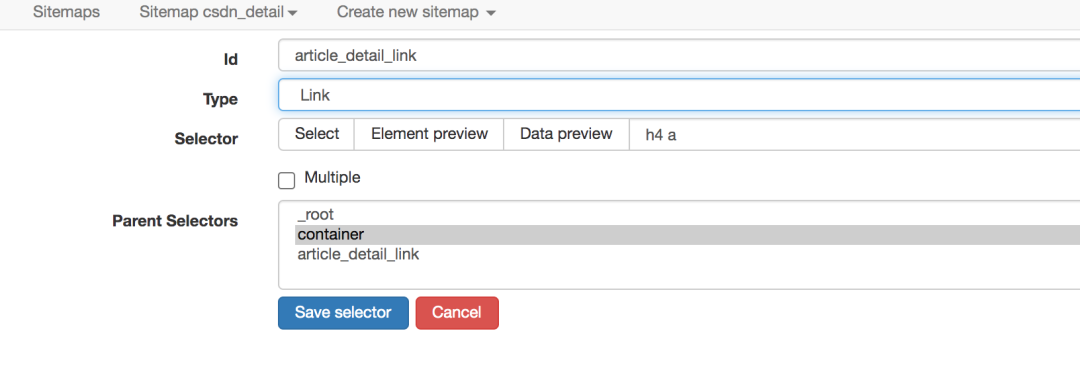

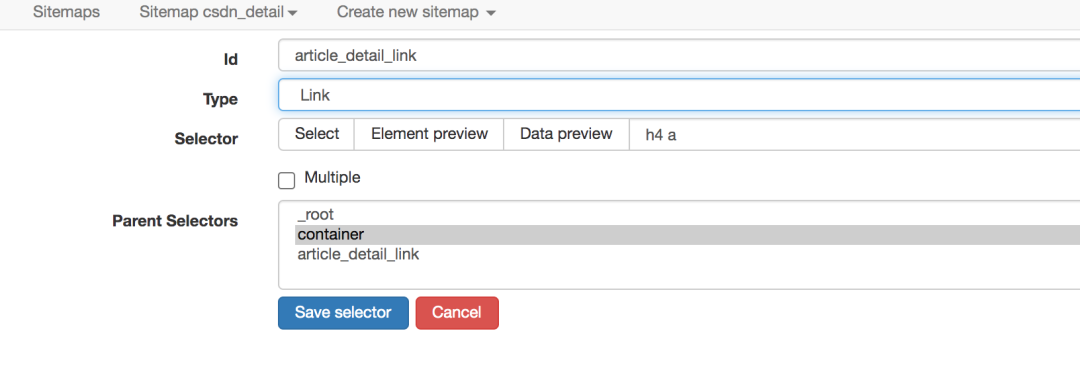

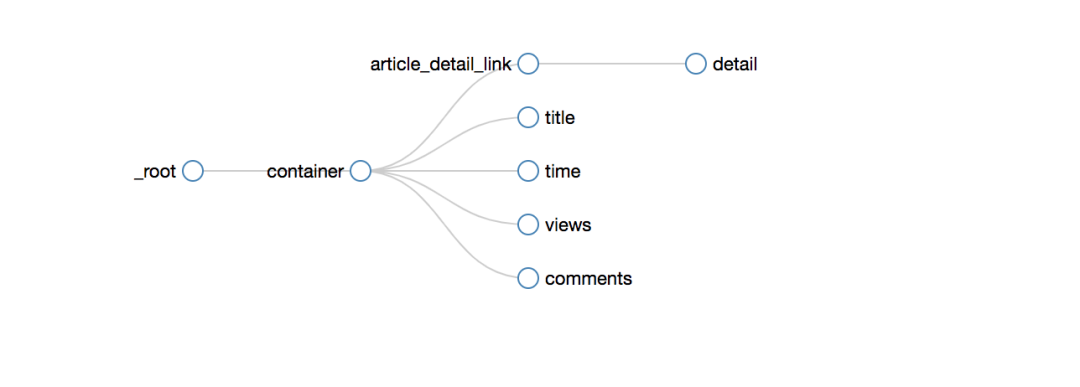

4.二级页面的爬取

CSDN的博客列表列表页,显示的信息比较粗略,只有标题,发表时间,阅读量,评论数,是否是原创。

如果你想获得更多的信息,比如博文的文字、点赞数、采集数、评论区的内容,你必须点击具体的博文链接才能查看它

网络爬虫的操作逻辑与人类似。如果你想抓取更详细的博文信息,你必须打开一个新页面来获取它,而网络爬虫的链接选择器就是这样做的。

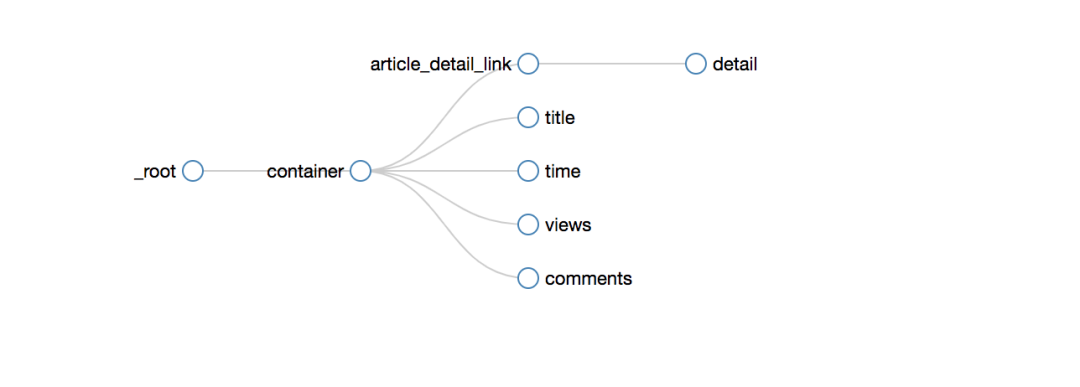

爬取路径的拓扑如下

爬取的效果如下

sitemap的配置如下,可以直接导入使用,下载配置文件:

5.写在最后

以上整理了分页和二级页面的爬取方案,主要是:分页器爬取和二级页面爬取。

只要学会了这两个,就已经可以处理绝大多数结构化的网络数据了。 查看全部

scrapy分页抓取网页(不重载页面的页面器爬取点入(1)_社会万象_光明网(组图))

一种是:点击下一页,只会重新渲染当前页面的一部分

在早期版本的 web-scraper 中,两种抓取方式是不同的。

需要重新加载的页面需要链接选择器

如果不需要重新加载页面,可以使用元素点击选择器

对于某些 网站 可以,但有很大的限制。

经过我的实验,使用Link选择器的第一个原理是取出下一页的a标签的超链接,然后去访问,但是并不是所有的网站的下一页都通过一个标签实现。

如果你使用js监听事件并像下面这样跳转,就不能使用Link选择器了。

新版网络爬虫特别支持导航分页器,并增加了分页选择器,可以完全适用于两种场景。下面我分别演示一下。

无需重新加载页面的分页器抓取

点击具体的CSDN博文,拉到底部查看评论区。

如果你的文章比较热门,有很多同学评论,CSDN会分页显示,但是不管在哪个页面,评论都属于同一篇文章文章,当您浏览任何页面的评论部分时,无需刷新博文,因为这种分页不会重新加载页面。

对于这种不需要重新加载页面的点击,可以使用Element Click来解决。

最后一点要注意root和next_page的选择,只有这样才能递归爬取

最终爬取效果如下

使用Element Click的站点地图配置如下,可以直接导入我的配置进行研究,下载配置文件:

当然,对于分页之类的东西,网络爬虫提供了更专业的分页选择器,更精简,效果最好

对应sitemap的配置如下,可以直接导入使用,下载配置文件:

寻呼机抓取以重新加载页面

CSDN博客文章列表,拉到底部,点击具体页面按钮,否则最右边的下一页会重新加载当前页面。

对于这种分页器,Element Click什么都做不了,读者可以自行验证,最多爬一页后就关闭了。

而作为分页选择器的分页自然适用

爬取的拓扑同上,这里不再赘述。

对应sitemap的配置如下,可以直接导入学习,下载配置文件:

4.二级页面的爬取

CSDN的博客列表列表页,显示的信息比较粗略,只有标题,发表时间,阅读量,评论数,是否是原创。

如果你想获得更多的信息,比如博文的文字、点赞数、采集数、评论区的内容,你必须点击具体的博文链接才能查看它

网络爬虫的操作逻辑与人类似。如果你想抓取更详细的博文信息,你必须打开一个新页面来获取它,而网络爬虫的链接选择器就是这样做的。

爬取路径的拓扑如下

爬取的效果如下

sitemap的配置如下,可以直接导入使用,下载配置文件:

5.写在最后

以上整理了分页和二级页面的爬取方案,主要是:分页器爬取和二级页面爬取。

只要学会了这两个,就已经可以处理绝大多数结构化的网络数据了。

scrapy分页抓取网页(-2.png页面抓取一条数据较为简单(图)信息 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 46 次浏览 • 2022-04-20 02:27

)

Scrapy 在页面上抓取一条数据相对简单。如果您在一个页面上抓取多条数据,则有一个技巧可以确定循环点的位置。

以简书首页为例。比如抢热门文章,一条信息包括:作者、文章标题、浏览量、评论数、点赞数、打赏数。一页上有多条数据。

-2.png

其实就是把页面上的数据提取出来封装成一个object item,但是最后没有放到采集里面。

物品定义

class JsuserItem(Item):

author = Field()

url = Field()

title = Field()

reads = Field()

comments = Field()

likes = Field()

rewards = Field()

提取数据的循环点应以收录一条信息和多条数据的标签开头,分析页面代码为div>li

-0.png

第一次提取的是一整块内容:(即多个数据块的内容)

infos = selector.xpath('//li/div')

第二次提取该节点下整个区块中的数据字段:

author = info.xpath('p/a/text()').extract()

title = info.xpath('h4/a/text()').extract()

-1.png

完整代码:

def parse(self, response):

selector = Selector(response)

infos = selector.xpath('//li/div')

for info in infos:

item = JsuserItem()

author = info.xpath('p/a/text()').extract()

title = info.xpath('h4/a/text()').extract()

url = info.xpath('h4/a/@href').extract()

reads = info.xpath('div/a[1]/text()').extract()

comments = info.xpath('div/a[2]/text()').extract()

likes = info.xpath('div/span[1]/text()').extract()

#注意有些文章是没有打赏的

rewards = info.xpath('div/span[2]/text()')

if len(rewards)==1 :

rds = info.xpath('div/span[2]/text()').extract()

rds = int(filter(str.isdigit,str(rds[0])))

else:

rds = 0

item['author']=author

item['title']=title

item['url']='http://www.jianshu.com'+url[0]

item['reads']=int(filter(str.isdigit,str(reads[0])))

item['comments']=int(filter(str.isdigit,str(comments[0])))

item['likes']=int(filter(str.isdigit,str(likes[0])))

item['rewards']=rds 查看全部

scrapy分页抓取网页(-2.png页面抓取一条数据较为简单(图)信息

)

Scrapy 在页面上抓取一条数据相对简单。如果您在一个页面上抓取多条数据,则有一个技巧可以确定循环点的位置。

以简书首页为例。比如抢热门文章,一条信息包括:作者、文章标题、浏览量、评论数、点赞数、打赏数。一页上有多条数据。

-2.png

其实就是把页面上的数据提取出来封装成一个object item,但是最后没有放到采集里面。

物品定义

class JsuserItem(Item):

author = Field()

url = Field()

title = Field()

reads = Field()

comments = Field()

likes = Field()

rewards = Field()

提取数据的循环点应以收录一条信息和多条数据的标签开头,分析页面代码为div>li

-0.png

第一次提取的是一整块内容:(即多个数据块的内容)

infos = selector.xpath('//li/div')

第二次提取该节点下整个区块中的数据字段:

author = info.xpath('p/a/text()').extract()

title = info.xpath('h4/a/text()').extract()

-1.png

完整代码:

def parse(self, response):

selector = Selector(response)

infos = selector.xpath('//li/div')

for info in infos:

item = JsuserItem()

author = info.xpath('p/a/text()').extract()

title = info.xpath('h4/a/text()').extract()

url = info.xpath('h4/a/@href').extract()

reads = info.xpath('div/a[1]/text()').extract()

comments = info.xpath('div/a[2]/text()').extract()

likes = info.xpath('div/span[1]/text()').extract()

#注意有些文章是没有打赏的

rewards = info.xpath('div/span[2]/text()')

if len(rewards)==1 :

rds = info.xpath('div/span[2]/text()').extract()

rds = int(filter(str.isdigit,str(rds[0])))

else:

rds = 0

item['author']=author

item['title']=title

item['url']='http://www.jianshu.com'+url[0]

item['reads']=int(filter(str.isdigit,str(reads[0])))

item['comments']=int(filter(str.isdigit,str(comments[0])))

item['likes']=int(filter(str.isdigit,str(likes[0])))

item['rewards']=rds

scrapy分页抓取网页(牛津小马哥web前端工程师陈小妹妹(之前)(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-04-19 16:44

)

原创:陈晓梅,Oxford Pony Brothers Web 前端工程师。

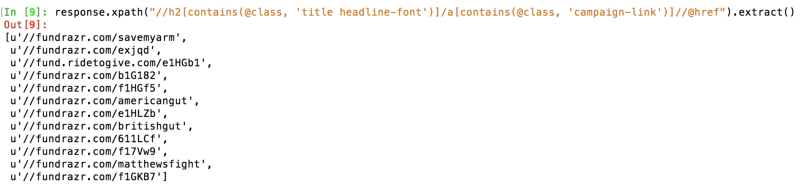

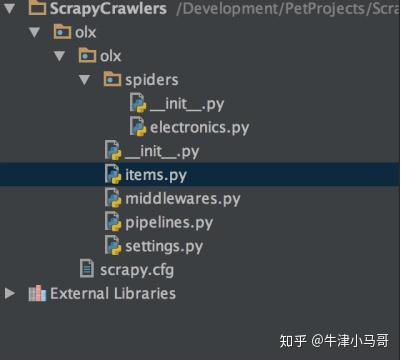

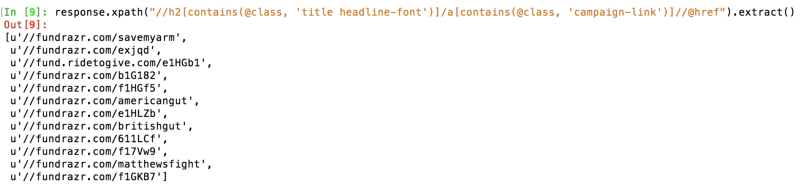

在本文中,我将编写一个网络爬虫,从 OLX 的电子和电器项目中抓取数据。但在我进入代码之前,这里先简要介绍一下 Scrapy 本身。

什么是刮痧?

Scrapy(发音为 Scrapy)是一个用 Python 编写的开源网络爬虫框架。最初是为网页抓取而设计的。目前由 Scrapinghub 维护。

>>>>

创建一个项目。

Scrapy的一个设计思路是一个项目可以收录多个爬虫。这种设计很有用,尤其是在为站点或子域的不同部分编写多个机器人时。所以首先创建项目:

Adnans-MBP:ScrapyCrawlers AdnanAhmad$ scrapy startproject olxNew

Scrapy project 'olx', using template directory '//anaconda/lib/python2.7/site-packages/scrapy/templates/project', created in:

/Development/PetProjects/ScrapyCrawlers/olx

You can start your first spider with:

cd olx

scrapy genspider example example.com

>>>>

创建爬虫

我运行了命令 scrapy startproject olx,它将创建一个名为 olx 的项目。接下来,进入新创建的文件夹,执行命令生成第一个爬虫,并带有要爬取的站点的名称和域:

Adnans-MBP:ScrapyCrawlers AdnanAhmad$ cd olx/

Adnans-MBP:olx AdnanAhmad$ scrapy genspider electronics www.olx.com.pk

Created spider 'electronics' using template 'basic' in module:

olx.spiders.electronics

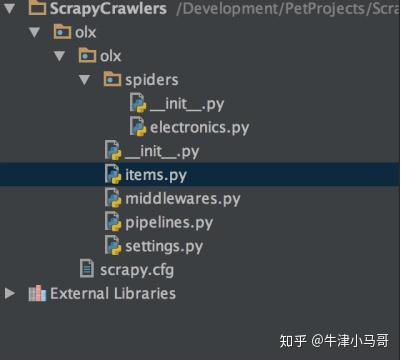

下面是 OLX 的“电子”文件部分,最终的项目结构将类似于以下示例:

如您所见,这个新创建的爬虫有一个单独的文件夹。您可以将多个爬虫添加到一个项目中。让我们打开爬虫文件electronics.py。当您打开它时,您将看到以下内容:

# -*- coding: utf-8 -*-

import scrapy

class ElectronicsSpider(scrapy.Spider):

name = "electronics"

allowed_domains = ["www.olx.com.pk"]

start_urls = ['http://www.olx.com.pk/']

def parse(self, response):

pass

如您所见,ElectronicsSpider 是 scrapy.Spider 的子类。name 属性其实就是蜘蛛的名字,在spider中指定。allowed_domains 属性告诉我们这个爬虫可以访问哪些域,start_urls 位置是需要首先访问初始 URL 的位置。

parse 顾名思义,这个方法会解析被访问页面的内容。由于我想写一个爬虫到多个页面,我会做一些改变。

from scrapy.spiders import CrawlSpider, Rule

from scrapy.linkextractors import LinkExtractor

class ElectronicsSpider(CrawlSpider):

name = "electronics"

allowed_domains = ["www.olx.com.pk"]

start_urls = [

'https://www.olx.com.pk/compute ... 39%3B,

'https://www.olx.com.pk/tv-video-audio/',

'https://www.olx.com.pk/games-e ... 39%3B

]

rules = (

Rule(LinkExtractor(allow=(), restrict_css=('.pageNextPrev',)),

callback="parse_item",

follow=True),)

def parse_item(self, response):

print('Processing..' + response.url)

为了让爬虫导航到多个页面,我从 scrapy.Spider 子类化为 CrawlSpider。这个类可以更容易地抓取 网站 的许多页面。您可以对生成的代码执行类似的操作,但您需要小心递归以导航下一页。

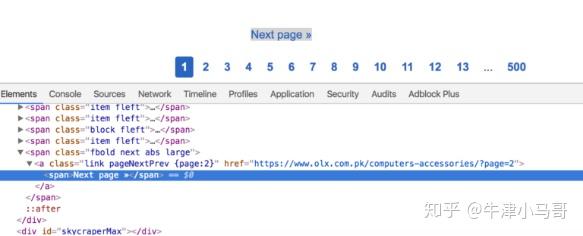

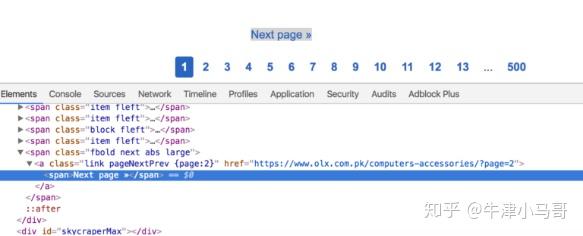

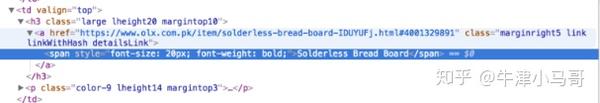

下一步是设置规则变量。在这里可以设置浏览网站的规则。在 LinkExtractor 中设置一些导航限制。这里我使用restrict_css参数来设置NEXT页面的类。如果您转到此页面并检查元素,您可以找到以下内容:

pageNextPrev 是用于获取下一页链接的类。call_back 参数告诉使用哪种方法来访问页面元素。

请记住,您需要将方法的名称从 parse() 更改为 parse_item() 或其他名称,以避免覆盖基类,否则即使您设置 follow=True ,您的规则也将不起作用。

到现在为止还挺好; 让我们测试一下到目前为止我们制作的爬虫。转到终端,在项目目录中输入:

scrapy crawl electronics

第三个参数其实是蜘蛛的名字,ElectronicsSpiders,之前在类名属性中设置的。在终端中,您会发现许多有助于调试的有用信息。如果不想看到调试信息,可以禁用调试器。此命令类似于 --nologswitch。

scrapy crawl --nolog electronics

如果现在运行,它将显示以下内容:

Adnans-MBP:olx AdnanAhmad$ scrapy crawl --nolog electronics

Processing..https://www.olx.com.pk/compute ... e%3D2

Processing..https://www.olx.com.pk/tv-video-audio/?page=2

Processing..https://www.olx.com.pk/games-entertainment/?page=2

Processing..https://www.olx.com.pk/computers-accessories/

Processing..https://www.olx.com.pk/tv-video-audio/

Processing..https://www.olx.com.pk/games-entertainment/

Processing..https://www.olx.com.pk/compute ... e%3D3

Processing..https://www.olx.com.pk/tv-video-audio/?page=3

Processing..https://www.olx.com.pk/games-entertainment/?page=3

Processing..https://www.olx.com.pk/compute ... e%3D4

Processing..https://www.olx.com.pk/tv-video-audio/?page=4

Processing..https://www.olx.com.pk/games-entertainment/?page=4

Processing..https://www.olx.com.pk/compute ... e%3D5

Processing..https://www.olx.com.pk/tv-video-audio/?page=5

Processing..https://www.olx.com.pk/games-entertainment/?page=5

Processing..https://www.olx.com.pk/compute ... e%3D6

Processing..https://www.olx.com.pk/tv-video-audio/?page=6

Processing..https://www.olx.com.pk/games-entertainment/?page=6

Processing..https://www.olx.com.pk/compute ... e%3D7

Processing..https://www.olx.com.pk/tv-video-audio/?page=7

Processing..https://www.olx.com.pk/games-entertainment/?page=7

由于我设置了follow=True,爬虫会检查NEXT页面的规则,并继续导航,直到到达不满足规则的页面,通常是列表的最后一页。

Scrapy 解除了编写爬虫的所有任务,让我可以专注于主要逻辑,通过编写爬虫来提取信息。

现在,我将继续编写代码以从列表页面获取单个项目链接。我将在 parse_item 方法中对其进行修改。

item_links = response.css('.large > .detailsLink::attr(href)').extract()

for a in item_links:

yield scrapy.Request(a, callback=self.parse_detail_page)

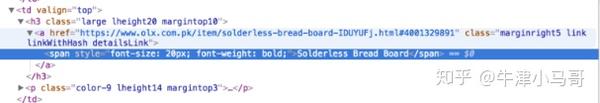

在这里,我使用 .css 响应方法获取链接。您也可以使用 xpath,这取决于您。在这种情况下,它非常简单:

锚链接有一个类 detailsLink。如果您只使用 response.css('.detailsLink'),由于 img 和 h3 标签中的重复链接,它将为单个条目选择重复链接。我还提到了用于唯一链接的大型父类。我之前提取的 href 部分 ::attr(href) 是链接本身。然后,我使用 extract() 方法。

使用此方法的原因是 .css 和 .xpath 返回 SelectorList 对象,而 extract() 有助于返回实际的 DOM 以供进一步处理。最后,我在 scrapy.Request 回调中收录了 yield 链接。我没有检查 Scrapy 的内部代码,但很可能他们使用的是 yield 而不是 A, return 因为你可以生产多个项目。由于爬虫需要同时处理多个链接,因此 yield 是这里的最佳选择。

parse_detail_page 顾名思义,这个方法会解析详情页中的个体信息。所以实际发生的是:

您将获得 parse_item 中的项目列表。

您将它们传递给回调方法以进行进一步处理。

由于它只是一个两层遍历,我可以借助两种方法到达最低层。如果要从OLX主页开始爬,这里要写三个方法:前两个获取子类及其条目,最后一个解析实际信息。知道了?

最后,我将解析实际信息,这些信息可以在与此类似的项目中找到。

解析此页面中的信息没有什么不同,但需要一些操作来存储解析的信息。我们需要为数据定义一个模型。这意味着我们需要告诉 Scrapy 我们想要存储哪些信息以供以后使用。让我们编辑之前由 Scrapy 生成的 item.py 文件。

import scrapy

class OlxItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

pass

OlxItem 我将设置所需字段以保存信息的类。我将为模型类定义三个字段。

class OlxItem(scrapy.Item):

# define the fields for your item here like:

title = scrapy.Field()

price = scrapy.Field()

url = scrapy.Field()

我将存储帖子的标题、价格和 URL 本身。

让我们回到爬虫类,修改parse_detail_page。

现在,一种方法是开始编写代码,通过运行整个爬虫来测试它,看看你是否走在正确的轨道上,但是 Scrapy 提供了另一个很棒的工具。

>>>>

废壳

Scrapy Shell 是一个命令行工具,允许您在不运行整个爬虫的情况下测试解析代码。与访问所有链接的爬虫不同,Scrapy Shell 保存单个页面的 DOM 以进行数据提取。就我而言,我做了以下事情:

Adnans-MBP:olx AdnanAhmad$ scrapy shell https://www.olx.com.pk/item/as ... 29891

现在我可以轻松地测试代码,而不必一次又一次地访问相同的 URL。我这样做是为了获得标题:

In [8]: response.css('h1::text').extract()[0].strip()

Out[8]: u"Asus Eee PC Atom Dual-Core 4CPU's Beautiful Laptops fresh Stock"

您可以在 response.css 中找到熟悉的内容。由于整个 DOM 都可用,因此您可以使用它。

我通过这样做得到价格:

In [11]: response.css('.pricelabel > strong::text').extract()[0]

Out[11]: u'Rs 10,500'

由于 response.url 返回的是当前访问的 URL,所以不需要做任何事情来获取 url。

现在已经检查了所有代码,是时候将其合并到 parse_detail_page 中了:

title = response.css('h1::text').extract()[0].strip()

price = response.css('.pricelabel > strong::text').extract()[0]

item = OlxItem()

item['title'] = title

item['price'] = price

item['url'] = response.url

yield item

解析所需信息后,OlxItem 将创建实例并设置属性。现在是时候运行爬虫并存储信息了,对命令进行了一些修改:

scrapy crawl electronics -o data.csv -t csv

我正在传递文件名和文件格式来保存数据。运行后,它将为您生成 CSV。很简单,不是吗?与您自己编写的爬虫不同,您必须编写自己的例程来保存数据。

可是等等!它并不止于此,您甚至可以获取 JSON 格式的数据。您所要做的就是使用 -t 开关传递 json。

Scrapy 为您提供了另一个功能。在实际情况下,传递一个固定的文件名没有任何意义。如何生成唯一的文件名?好吧,为此,您需要修改 settings.py 文件并添加以下两个条目:

FEED_URI = 'data/%(name)s/%(time)s.json'

FEED_FORMAT = 'json'

这里我给出文件的模式,%(name)% 是爬虫本身的名字和时间戳。你可以在这里了解更多。现在,当我运行 scrapy crawl --nolog electronics 或 scrapy crawl electronics 时,它会在 data 文件夹中生成一个 JSON 文件,如下所示:

[

{"url": "https://www.olx.com.pk/item/ac ... ot%3B, "price": "Rs 42,000", "title": "Acer Ultra Slim Gaming Laptop with AMD FX Processor 3GB Dedicated"},

{"url": "https://www.olx.com.pk/item/sa ... ot%3B, "price": "Rs 80,000", "title": "Saw Machine"},

{"url": "https://www.olx.com.pk/item/la ... ot%3B, "price": "Rs 22,000", "title": "Laptop HP Probook 6570b Core i 5 3rd Gen"},

{"url": "https://www.olx.com.pk/item/zo ... ot%3B, "price": "Rs 4,000", "title": "Zong 4g could mifi anlock all Sim supported"},

...

] 查看全部

scrapy分页抓取网页(牛津小马哥web前端工程师陈小妹妹(之前)(图)

)

原创:陈晓梅,Oxford Pony Brothers Web 前端工程师。

在本文中,我将编写一个网络爬虫,从 OLX 的电子和电器项目中抓取数据。但在我进入代码之前,这里先简要介绍一下 Scrapy 本身。

什么是刮痧?

Scrapy(发音为 Scrapy)是一个用 Python 编写的开源网络爬虫框架。最初是为网页抓取而设计的。目前由 Scrapinghub 维护。

>>>>

创建一个项目。

Scrapy的一个设计思路是一个项目可以收录多个爬虫。这种设计很有用,尤其是在为站点或子域的不同部分编写多个机器人时。所以首先创建项目:

Adnans-MBP:ScrapyCrawlers AdnanAhmad$ scrapy startproject olxNew

Scrapy project 'olx', using template directory '//anaconda/lib/python2.7/site-packages/scrapy/templates/project', created in:

/Development/PetProjects/ScrapyCrawlers/olx

You can start your first spider with:

cd olx

scrapy genspider example example.com

>>>>

创建爬虫

我运行了命令 scrapy startproject olx,它将创建一个名为 olx 的项目。接下来,进入新创建的文件夹,执行命令生成第一个爬虫,并带有要爬取的站点的名称和域:

Adnans-MBP:ScrapyCrawlers AdnanAhmad$ cd olx/

Adnans-MBP:olx AdnanAhmad$ scrapy genspider electronics www.olx.com.pk