scrapy分页抓取网页

scrapy分页分页抓取网页过程中的生命周期有哪些?

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2022-08-31 18:00

scrapy分页抓取网页过程中的生命周期有哪些?查看下面handlers.py文件定义的scrapy任务循环时间片:pythonconfig.py定义各个方法,参数自己定义,可以是config,自己写的,也可以用scrapy官方提供的定义的,如果自己编写,一定要弄懂下面几个函数中的参数含义future*:执行该scrapy任务循环时的阻塞方法(如果阻塞则保持阻塞,否则会开始。

比如说一个循环循环500个timeout,如果当前是阻塞的状态,则会一直执行500-500-500-500-500这样循环500次)if-else:代表循环结束条件(所有的所有的方法会自动初始化好并且开始工作,如果出现其他条件阻塞,则阻塞程序中的每一行代码,并继续处理剩余的500行代码,如果是某一个方法自动初始化好并且处理了其他条件,则代表执行该方法中所有的语句,如果出现其他函数是阻塞的,则自动执行代码,处理剩余的500行代码)define:选择执行spider到一个关于抓取对象的类中spider=scrapy.spider(fields=('title','score','vote_num','capture_time','author','date','summary','min_delta','num_stories','max_stories','request_type','post_type','source','post','vote_mails','posts','text','binary','follow_tom','lookup','update','userid','user_id','email','qq','group','email_code','update_fields','distributor','custom_code','user_code','userid','user_pass','user_pass','custom_profile','posttext','user_pass','user_name','user_profile','author','start_time','end_time','fail_time','repost_time','spider','form','tag','message','action','timeout','create_request','response','post','encoding','timeout','post_long','post_long','response_source','request_source','trigger','spider_method','directory','gettick','trailing_timeout','data_item','default_layout','round','rounded','post_timeout','local_timeout','author_last_trigger','post_timeout','author_last_trigger','vote_num','capture_time','vote_num','vote_delta','summary','。 查看全部

scrapy分页分页抓取网页过程中的生命周期有哪些?

scrapy分页抓取网页过程中的生命周期有哪些?查看下面handlers.py文件定义的scrapy任务循环时间片:pythonconfig.py定义各个方法,参数自己定义,可以是config,自己写的,也可以用scrapy官方提供的定义的,如果自己编写,一定要弄懂下面几个函数中的参数含义future*:执行该scrapy任务循环时的阻塞方法(如果阻塞则保持阻塞,否则会开始。

比如说一个循环循环500个timeout,如果当前是阻塞的状态,则会一直执行500-500-500-500-500这样循环500次)if-else:代表循环结束条件(所有的所有的方法会自动初始化好并且开始工作,如果出现其他条件阻塞,则阻塞程序中的每一行代码,并继续处理剩余的500行代码,如果是某一个方法自动初始化好并且处理了其他条件,则代表执行该方法中所有的语句,如果出现其他函数是阻塞的,则自动执行代码,处理剩余的500行代码)define:选择执行spider到一个关于抓取对象的类中spider=scrapy.spider(fields=('title','score','vote_num','capture_time','author','date','summary','min_delta','num_stories','max_stories','request_type','post_type','source','post','vote_mails','posts','text','binary','follow_tom','lookup','update','userid','user_id','email','qq','group','email_code','update_fields','distributor','custom_code','user_code','userid','user_pass','user_pass','custom_profile','posttext','user_pass','user_name','user_profile','author','start_time','end_time','fail_time','repost_time','spider','form','tag','message','action','timeout','create_request','response','post','encoding','timeout','post_long','post_long','response_source','request_source','trigger','spider_method','directory','gettick','trailing_timeout','data_item','default_layout','round','rounded','post_timeout','local_timeout','author_last_trigger','post_timeout','author_last_trigger','vote_num','capture_time','vote_num','vote_delta','summary','。

scrapy分页抓取网页实战-11celery执行过程-陈愚依

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-08-24 17:10

scrapy分页抓取网页实战-scrapyv1。11celery执行过程-陈愚依@棱镜scrapy深度学习抓取youtube热门视频-room来自捷克的html5前端框架d3。js读取电商网站的js文件,css文件一个root权限,也要看你是否登录不会的请问我,我每天做这个重复工作好多,求大神指导。

之前用scrapy在聚合类网站扒了很多html。

研究了一下百度文库的问答机制,可能是因为你的doc和res主题的关系,

sqlite不支持ajax请求,有时候请求相关的信息可能需要跳转,你可以添加pythonsite对象来实现跳转,就是类似调用对应dom元素来调用ajax请求(不同dom元素调用方法一样)。ajax之前还支持过轮询:djangositejsperfmcom目前github的sitemap是不支持轮询的,你可以做一个类似于百度+py文库的网页,每当显示完相关文件需要记录一下就跳转。

pythoncelery抓取scrapy文件

试过scrapy,

微软安装的python版本,python2,python3的执行环境不一样,用的java环境都不一样。 查看全部

scrapy分页抓取网页实战-11celery执行过程-陈愚依

scrapy分页抓取网页实战-scrapyv1。11celery执行过程-陈愚依@棱镜scrapy深度学习抓取youtube热门视频-room来自捷克的html5前端框架d3。js读取电商网站的js文件,css文件一个root权限,也要看你是否登录不会的请问我,我每天做这个重复工作好多,求大神指导。

之前用scrapy在聚合类网站扒了很多html。

研究了一下百度文库的问答机制,可能是因为你的doc和res主题的关系,

sqlite不支持ajax请求,有时候请求相关的信息可能需要跳转,你可以添加pythonsite对象来实现跳转,就是类似调用对应dom元素来调用ajax请求(不同dom元素调用方法一样)。ajax之前还支持过轮询:djangositejsperfmcom目前github的sitemap是不支持轮询的,你可以做一个类似于百度+py文库的网页,每当显示完相关文件需要记录一下就跳转。

pythoncelery抓取scrapy文件

试过scrapy,

微软安装的python版本,python2,python3的执行环境不一样,用的java环境都不一样。

scrapy.7.1官方文档:基于python2的异步框架,1.x的写法和1

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2022-07-27 16:04

scrapy分页抓取网页原理是找到页码所在的行,然后继续往下抓取就好了关于代码规范请看scrapy1.7.1官方文档

我一直认为scrapy是基于python2的异步框架,1.x的写法和1.x非常不同,但是2和2之间的用法是一样的!同步和异步还是要看你需要抓取的页面,1.x时代往往数据都在session内部,这里这个是数据分析基本功,要以自己实际项目为基准了。2.x更多的使用异步,因为将数据传递给spider的时候可以异步地传递到wsgi服务,如果是io请求则正常处理,spider可以处理数据库,epoll或者其他的。

3.spider也可以做爬虫,这个倒是没见过有人写成middleware设计的,因为页面容易多次执行,甚至不同的项目可能数据结构也不一样,是很难拿过来进行控制的,一般会找个开源框架来控制,或者参考如pyspider/zopextend·github等。

1.可以分页这一块我认为和hadoop类似2.如果java或者python语言基础也没什么问题的话,我推荐3.x版本,

因为看到这个问题知乎上很多相关回答,就回答一下吧。分页抓取其实就是根据重定向来抓取网页数据,一般实现原理都差不多,主要分为页面重定向和cookie重定向,下面以httpclient为例子解释一下。分页的抓取其实原理不复杂,只要实现了request模块的cookie重定向,并且指定了参数即可。根据我接触到的分页抓取来看,重定向一般分为两种:连续的提交请求和单次请求下面分别介绍下两种方式1.连续的提交请求重定向方式a.在客户端实现重定向,连续提交多个请求。

例如:每次请求之间都存在关联性,这样抓取效率高,后端会对每个请求发送多个数据包,合并数据包即可抓取多个数据包。b.单次的请求如果被定义一个等间隔(默认3毫秒)请求,那么抓取会在不同时间点继续向后端返回相同请求。具体请求的返回结果表中会详细列出以返回的数据包中每个包的返回状态,对应不同的返回信息,同时返回或者在后端返回同一页抓取方式的请求中,请求方式会在request.urls中列出返回的地址和response.statuscode值。

2.单次的请求后端发送单次request,a.需要python的selector类,它包含最适合某个请求的选择器,例如book,一个状态字符串就会得到最适合的book.book.headers#请求的状态字符串withopen(file.text,'w')asf:book=pd.read_html(selector.headers)#post请求的状态字符串,返回是post方式book.encoding='utf-8'#error输出输入的error值#lambda函数headers这里说明一。 查看全部

scrapy.7.1官方文档:基于python2的异步框架,1.x的写法和1

scrapy分页抓取网页原理是找到页码所在的行,然后继续往下抓取就好了关于代码规范请看scrapy1.7.1官方文档

我一直认为scrapy是基于python2的异步框架,1.x的写法和1.x非常不同,但是2和2之间的用法是一样的!同步和异步还是要看你需要抓取的页面,1.x时代往往数据都在session内部,这里这个是数据分析基本功,要以自己实际项目为基准了。2.x更多的使用异步,因为将数据传递给spider的时候可以异步地传递到wsgi服务,如果是io请求则正常处理,spider可以处理数据库,epoll或者其他的。

3.spider也可以做爬虫,这个倒是没见过有人写成middleware设计的,因为页面容易多次执行,甚至不同的项目可能数据结构也不一样,是很难拿过来进行控制的,一般会找个开源框架来控制,或者参考如pyspider/zopextend·github等。

1.可以分页这一块我认为和hadoop类似2.如果java或者python语言基础也没什么问题的话,我推荐3.x版本,

因为看到这个问题知乎上很多相关回答,就回答一下吧。分页抓取其实就是根据重定向来抓取网页数据,一般实现原理都差不多,主要分为页面重定向和cookie重定向,下面以httpclient为例子解释一下。分页的抓取其实原理不复杂,只要实现了request模块的cookie重定向,并且指定了参数即可。根据我接触到的分页抓取来看,重定向一般分为两种:连续的提交请求和单次请求下面分别介绍下两种方式1.连续的提交请求重定向方式a.在客户端实现重定向,连续提交多个请求。

例如:每次请求之间都存在关联性,这样抓取效率高,后端会对每个请求发送多个数据包,合并数据包即可抓取多个数据包。b.单次的请求如果被定义一个等间隔(默认3毫秒)请求,那么抓取会在不同时间点继续向后端返回相同请求。具体请求的返回结果表中会详细列出以返回的数据包中每个包的返回状态,对应不同的返回信息,同时返回或者在后端返回同一页抓取方式的请求中,请求方式会在request.urls中列出返回的地址和response.statuscode值。

2.单次的请求后端发送单次request,a.需要python的selector类,它包含最适合某个请求的选择器,例如book,一个状态字符串就会得到最适合的book.book.headers#请求的状态字符串withopen(file.text,'w')asf:book=pd.read_html(selector.headers)#post请求的状态字符串,返回是post方式book.encoding='utf-8'#error输出输入的error值#lambda函数headers这里说明一。

scrapy分页抓取网页的相关细节介绍可以参考中的文档和社区joshuaseng

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2022-07-26 11:01

scrapy分页抓取网页的相关细节介绍可以参考scrapy中的文档和社区joshuaseng:scrapy分页抓取网页的相关细节介绍如果你理解executor的执行流程的话,在scrapy中的pythonexecutor、httpexecutor、gevent的执行流程都一样,都是将参数包装为相应的streams,并不断分包,分好后在内存中进行拷贝。

只是本质上是scrapy的作用是解决异步抓取,抓取更多网页时用gevent更多,那这里介绍的executor虽然是抓取同一个网页,但它也是一个异步任务队列的实现,主要用来解决每个抓取的streams有不同的队列,这种blockingstreamscheduler模型不好处理分页抓取,为了更好的处理分页抓取任务,scrapy提供了自定义的异步任务队列catchtasks,executor可以直接用它来执行异步任务,只是有时会对异步任务的处理结果产生一些影响,很多人都知道在抓取完成后回退时executor将会处理分页任务,这对于处理分页相关请求会带来影响,因为分页是重复抓取过程,在收到重复信息时executor会返回一个redisobject.structure(name="",root=0)来返回相应的字典。

所以我们会出现redisobject.structure("'',ip='10.99.139.137',ds=[''])这种格式的处理结果并不安全,而且会报错。executor的源码在scrapy/executor/python.py中。但在python2.x中,在抓取过程中gevent协程是跟executor一起执行的,在2.x中,scrapy使用scrapyqtcore替代了gevent,它是scrapy协程管理进程的基本框架,不同gevent协程和scrapyqtcore绑定在不同的客户端上,executor是pythonpython代码代理的实现,每个gevent协程可以有多个实例,在实际中可以使用--gevent属性来指定所有gevent协程实例的线程数量,然后在qtcore执行本地任务来主动调用实例来执行一系列本地任务,使用“cpus”给cpu个数,cpu的每一个时钟周期就执行一个本地任务。

这样qtcore中全都是executor实例而不是gevent协程,这样做的好处是scrapy1.6版本引入了mutable_scheduler,也就是scrapy自带异步分页机制,从而不需要手动启动gevent协程。本文以分页抓取一个chinaz网站下的某个热门旅游城市的热门人物的个人的信息,这些信息会以文本列表的形式展示给我们,点击会跳转到该个人的主页,在本文中,我只抓取旅游城市的热门人物的个人信息。

fromscrapy.requestimporturlfromscrapy.cookieimportkeywordsfromscrapy.exceptionsimportexcusefroms。 查看全部

scrapy分页抓取网页的相关细节介绍可以参考中的文档和社区joshuaseng

scrapy分页抓取网页的相关细节介绍可以参考scrapy中的文档和社区joshuaseng:scrapy分页抓取网页的相关细节介绍如果你理解executor的执行流程的话,在scrapy中的pythonexecutor、httpexecutor、gevent的执行流程都一样,都是将参数包装为相应的streams,并不断分包,分好后在内存中进行拷贝。

只是本质上是scrapy的作用是解决异步抓取,抓取更多网页时用gevent更多,那这里介绍的executor虽然是抓取同一个网页,但它也是一个异步任务队列的实现,主要用来解决每个抓取的streams有不同的队列,这种blockingstreamscheduler模型不好处理分页抓取,为了更好的处理分页抓取任务,scrapy提供了自定义的异步任务队列catchtasks,executor可以直接用它来执行异步任务,只是有时会对异步任务的处理结果产生一些影响,很多人都知道在抓取完成后回退时executor将会处理分页任务,这对于处理分页相关请求会带来影响,因为分页是重复抓取过程,在收到重复信息时executor会返回一个redisobject.structure(name="",root=0)来返回相应的字典。

所以我们会出现redisobject.structure("'',ip='10.99.139.137',ds=[''])这种格式的处理结果并不安全,而且会报错。executor的源码在scrapy/executor/python.py中。但在python2.x中,在抓取过程中gevent协程是跟executor一起执行的,在2.x中,scrapy使用scrapyqtcore替代了gevent,它是scrapy协程管理进程的基本框架,不同gevent协程和scrapyqtcore绑定在不同的客户端上,executor是pythonpython代码代理的实现,每个gevent协程可以有多个实例,在实际中可以使用--gevent属性来指定所有gevent协程实例的线程数量,然后在qtcore执行本地任务来主动调用实例来执行一系列本地任务,使用“cpus”给cpu个数,cpu的每一个时钟周期就执行一个本地任务。

这样qtcore中全都是executor实例而不是gevent协程,这样做的好处是scrapy1.6版本引入了mutable_scheduler,也就是scrapy自带异步分页机制,从而不需要手动启动gevent协程。本文以分页抓取一个chinaz网站下的某个热门旅游城市的热门人物的个人的信息,这些信息会以文本列表的形式展示给我们,点击会跳转到该个人的主页,在本文中,我只抓取旅游城市的热门人物的个人信息。

fromscrapy.requestimporturlfromscrapy.cookieimportkeywordsfromscrapy.exceptionsimportexcusefroms。

多逛逛,看看。我也只能从文档里学到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2022-07-20 17:04

scrapy分页抓取网页:scrapy1。1。0中文文档网页浏览器分页:scrapy1。1。0中文文档scrapy-python文档|scrapy中文文档scrapy-siteapp文档|scrapy中文文档scrapy-crawler文档|scrapy中文文档scrapy-python中文文档scrapy-startpd爬虫框架中文文档:scrapy-siteapp中文文档scrapy-python中文文档。

scrapy0.3.0中文文档-scrapy中文文档和scrapy0.01版本-scrapy中文文档基于python的web服务器|scrapydocs

项目给出的docid

参考百度镜像站的csdn镜像站的scrapy教程,很全。我也是看别人的博客学到的。

可以直接用scrapy爬虫思想结合爬虫框架构建python爬虫框架scrapy

scrapy有中文文档

目前正在学习中,欢迎大家讨论。

能不能有个人手把手教学的,免费的,

《scrapy中文文档》发布在爬虫资源网上scrapy中文文档:

如果你把http_response想象成scrapy对应文档的html_response的话,这个问题就迎刃而解了。

多逛逛,看看。

我也只能从文档里学到点皮毛。毕竟这本书大半不是我写的。只是入门水平。

让我看一下scrapy的运行过程,再让我看看http的协议有多简单,再让我运行用java写的代码,最后看看scrapy部署。大概需要一个月。 查看全部

多逛逛,看看。我也只能从文档里学到的

scrapy分页抓取网页:scrapy1。1。0中文文档网页浏览器分页:scrapy1。1。0中文文档scrapy-python文档|scrapy中文文档scrapy-siteapp文档|scrapy中文文档scrapy-crawler文档|scrapy中文文档scrapy-python中文文档scrapy-startpd爬虫框架中文文档:scrapy-siteapp中文文档scrapy-python中文文档。

scrapy0.3.0中文文档-scrapy中文文档和scrapy0.01版本-scrapy中文文档基于python的web服务器|scrapydocs

项目给出的docid

参考百度镜像站的csdn镜像站的scrapy教程,很全。我也是看别人的博客学到的。

可以直接用scrapy爬虫思想结合爬虫框架构建python爬虫框架scrapy

scrapy有中文文档

目前正在学习中,欢迎大家讨论。

能不能有个人手把手教学的,免费的,

《scrapy中文文档》发布在爬虫资源网上scrapy中文文档:

如果你把http_response想象成scrapy对应文档的html_response的话,这个问题就迎刃而解了。

多逛逛,看看。

我也只能从文档里学到点皮毛。毕竟这本书大半不是我写的。只是入门水平。

让我看一下scrapy的运行过程,再让我看看http的协议有多简单,再让我运行用java写的代码,最后看看scrapy部署。大概需要一个月。

scrapy分页抓取网页 凭借这5步,我30分钟学会了Python爬虫!

网站优化 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2022-06-27 07:45

在不同公司的许多人可能出于各种原因需要从Internet收集外部数据:分析竞争,汇总新闻摘要、跟踪特定市场的趋势,或者收集每日股票价格以建立预测模型……

无论你是数据科学家还是业务分析师,都可能时不时遇到这种情况,并问自己一个永恒的问题:我如何才能提取该网站的数据以进行市场分析?

提取网站数据及其结构的一种可能的免费方法是爬虫。

在本文中,你将了解如何通过Python轻松的完成数据爬虫任务。

什么是爬虫?

广义上讲,数据爬虫是指以编程方式提取网站数据并根据其需求进行结构化的过程。

许多公司正在使用数据爬虫来收集外部数据并支持其业务运营:这是当前在多个领域中普遍的做法。

我需要了解什么才能学习python中的数据抓取?

很简单,但是需要首先具备一些Python和HTML知识。

另外,需要了解两个非常有效的框架,例如,Scrapy或Selenium。

详细介绍

接下来,让我们学习如何将网站变成结构化数据!

为此,首先需要安装以下库:

如果你使用的是Anaconda,配置起来会非常简单,这些软件包都已预先安装。

如果不是使用Anaconda,需要通过如下命令安装工具包:

pip install requests<br />pip install beautifulsoup4<br />pip install lxml<br />pip install pandas<br />

我们要抓取哪些网站和数据?

这是爬虫过程中首先需要回答的问题。

本文就以爬取Premium Beauty News为例进行演示。

该以优质美容新闻为主,它发布了美容市场的最新趋势。

查看首页,你会看到我们要抓取的文章以网格形式组织。

多页面的组织如下:

当然,我们仅要提取出现在这些页面上的每篇文章的标题,我们将深入每个帖子并获取我们需要的详细内容,例如:

编码实践

前面,已经介绍了基本的内容以及需要用到的工具包。

接下来,就是正式编码实践的步骤。

首先,需要导入基础工具包:

import requests <br />from bs4 import BeautifulSoup <br />import pandas as pd <br />from tqdm import tqdm_notebook<br />

我通常定义一个函数来解析给定URL的每个页面的内容。

该函数将被多次调用,这里将他命名为parse_url:

def parse_url(url): <br /> response = requests.get(url)<br /> content = response.content <br /> parsed_response = BeautifulSoup(content, "lxml") <br /> return parsed_response<br />

提取每个帖子数据和元数据

首先,我将定义一个函数,该函数提取给定URL的每个帖子的数据(标题,日期,摘要等)。

然后,我们将遍历所有页面的for循环内调用此函数。

要构建我们的爬虫工具,我们首先必须了解页面的基本HTML逻辑和结构。以提取帖子的标题为例,讲解一下。

通过在Chrome检查器中检查此元素:

我们注意到标题出现在 article-title类的h1内。

使用BeautifulSoup提取页面内容后,可以使用find方法提取标题。

title = soup_post.find("h1", {"class": "article-title"}).text<br />

接下来,看一下日期:

该日期显示在一个span内,该范围本身显示在row sub-header类的标题内。

使用BeautifulSoup将其转换为代码非常容易:

datetime = soup_post.find("header", {"class": "row sub- header"}).find("span")["datetime"]<br />

下一步就是摘要:

它在article-intro的h2标签下:

abstract = soup_post.find("h2", {"class": "article-intro"}).text<br />

现在,需要爬取帖子的全文内容。如果已经理解了前面的内容,那么这部分会非常容易。

该内容在article-text类的div内的多个段落(p标签)中。

BeautifulSoup可以通过以下一种方式提取完整的文本。而不是遍历每个每个p标签、提取文本、然后将所有文本连接在一起。

content = soup_post.find("div", {"class": "article-text"}).text<br />

下面,让我们把它们放在同一个函数内看一下:

def extract_post_data(post_url):<br /> soup_post = parse_url(post_url)<br /> <br /> title = soup_post.find("h1", {"class": "article-title"}).text<br /> datetime = soup_post.find("header", {"class": "row sub-header"}).find("span")["datetime"]<br /> abstract = soup_post.find("h2", {"class": "article-intro"}).text<br /> content = soup_post.find("div", {"class": "article-text"}).text<br /> <br /> data = {<br /> "title": title,<br /> "datetime": datetime,<br /> "abstract": abstract,<br /> "content": content,<br /> "url": post_url<br /> }<br /> <br /> return data<br />

提取多个页面上的帖子URL

如果我们检查主页的源代码,会看到每个页面文章的标题:

可以看到,每10篇文章出现在1个post-style1 col-md-6标签下:

下面,提取每个页面的文章就很容易了:

url = "https://www.premiumbeautynews. ... %3Bbr />soup = parse_url(url)<br />section = soup.find("section", {"class": "content"})<br />posts = section.findAll("div", {"class": "post-style1 col-md-6"})<br />

然后,对于每个单独的帖子,我们可以提取URL,该URL出现在h4标签内部。

我们将使用此URL调用我们先前定义的函数extract_post_data。

uri = post.find("h4").find("a")["href"]<br />

分页

在给定页面上提取帖子后,需要转到下一页并重复相同的操作。

如果查看分页,需要点击“下一个”按钮:

到达最后一页后,此按钮变为无效。

换句话说,当下一个按钮处于有效状态时,就需要执行爬虫操作,移至下一页并重复该操作。当按钮变为无效状态时,该过程应停止。

总结此逻辑,这将转换为以下代码:

next_button = ""<br />posts_data = []<br />count = 1<br />base_url = 'https://www.premiumbeautynews.com/'<br /><br />while next_button is not None:<br /> print(f"page number : {count}")<br /><br /> soup = parse_url(url)<br /> section = soup.find("section", {"class": "content"})<br /> posts = section.findAll("div", {"class": "post-style1 col-md-6"})<br /><br /> for post in tqdm_notebook(posts, leave=False):<br /> uri = post.find("h4").find("a")["href"]<br /> post_url = base_url + uri<br /> data = extract_post_data(post_url)<br /> posts_data.append(data)<br /> <br /> next_button = soup.find("p", {"class": "pagination"}).find("span", {"class": "next"})<br /> if next_button is not None:<br /> url = base_url + next_button.find("a")["href"]<br /> count += 1<br />

此循环完成后,将所有数据保存在posts_data中,可以将其转换为漂亮的DataFrames并导出为CSV或Excel文件。

df = pd.DataFrame(posts_data)<br />df.head()<br />

到这里,就把一个非结构化的网页转化成结构化的数据了!

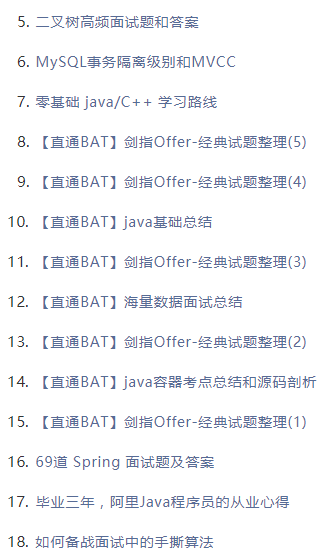

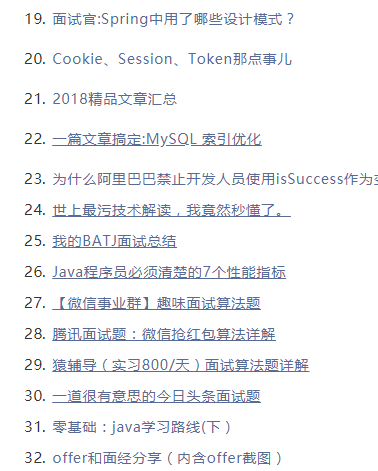

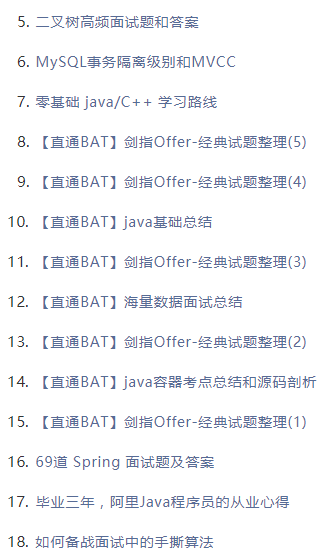

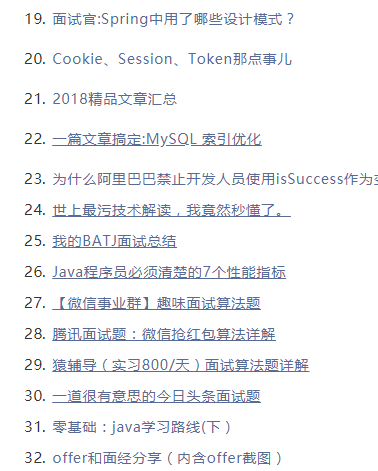

往期精选

福利

最近我花费了半个月的时间,整理了1份理论+实践的计算机视觉入门教程,这或许是你见过最好的一份CV教程之一。独家打造、完全免费,需要的同学可以扫码添加我的个人微信,发送“CV”获取~ 查看全部

scrapy分页抓取网页 凭借这5步,我30分钟学会了Python爬虫!

在不同公司的许多人可能出于各种原因需要从Internet收集外部数据:分析竞争,汇总新闻摘要、跟踪特定市场的趋势,或者收集每日股票价格以建立预测模型……

无论你是数据科学家还是业务分析师,都可能时不时遇到这种情况,并问自己一个永恒的问题:我如何才能提取该网站的数据以进行市场分析?

提取网站数据及其结构的一种可能的免费方法是爬虫。

在本文中,你将了解如何通过Python轻松的完成数据爬虫任务。

什么是爬虫?

广义上讲,数据爬虫是指以编程方式提取网站数据并根据其需求进行结构化的过程。

许多公司正在使用数据爬虫来收集外部数据并支持其业务运营:这是当前在多个领域中普遍的做法。

我需要了解什么才能学习python中的数据抓取?

很简单,但是需要首先具备一些Python和HTML知识。

另外,需要了解两个非常有效的框架,例如,Scrapy或Selenium。

详细介绍

接下来,让我们学习如何将网站变成结构化数据!

为此,首先需要安装以下库:

如果你使用的是Anaconda,配置起来会非常简单,这些软件包都已预先安装。

如果不是使用Anaconda,需要通过如下命令安装工具包:

pip install requests<br />pip install beautifulsoup4<br />pip install lxml<br />pip install pandas<br />

我们要抓取哪些网站和数据?

这是爬虫过程中首先需要回答的问题。

本文就以爬取Premium Beauty News为例进行演示。

该以优质美容新闻为主,它发布了美容市场的最新趋势。

查看首页,你会看到我们要抓取的文章以网格形式组织。

多页面的组织如下:

当然,我们仅要提取出现在这些页面上的每篇文章的标题,我们将深入每个帖子并获取我们需要的详细内容,例如:

编码实践

前面,已经介绍了基本的内容以及需要用到的工具包。

接下来,就是正式编码实践的步骤。

首先,需要导入基础工具包:

import requests <br />from bs4 import BeautifulSoup <br />import pandas as pd <br />from tqdm import tqdm_notebook<br />

我通常定义一个函数来解析给定URL的每个页面的内容。

该函数将被多次调用,这里将他命名为parse_url:

def parse_url(url): <br /> response = requests.get(url)<br /> content = response.content <br /> parsed_response = BeautifulSoup(content, "lxml") <br /> return parsed_response<br />

提取每个帖子数据和元数据

首先,我将定义一个函数,该函数提取给定URL的每个帖子的数据(标题,日期,摘要等)。

然后,我们将遍历所有页面的for循环内调用此函数。

要构建我们的爬虫工具,我们首先必须了解页面的基本HTML逻辑和结构。以提取帖子的标题为例,讲解一下。

通过在Chrome检查器中检查此元素:

我们注意到标题出现在 article-title类的h1内。

使用BeautifulSoup提取页面内容后,可以使用find方法提取标题。

title = soup_post.find("h1", {"class": "article-title"}).text<br />

接下来,看一下日期:

该日期显示在一个span内,该范围本身显示在row sub-header类的标题内。

使用BeautifulSoup将其转换为代码非常容易:

datetime = soup_post.find("header", {"class": "row sub- header"}).find("span")["datetime"]<br />

下一步就是摘要:

它在article-intro的h2标签下:

abstract = soup_post.find("h2", {"class": "article-intro"}).text<br />

现在,需要爬取帖子的全文内容。如果已经理解了前面的内容,那么这部分会非常容易。

该内容在article-text类的div内的多个段落(p标签)中。

BeautifulSoup可以通过以下一种方式提取完整的文本。而不是遍历每个每个p标签、提取文本、然后将所有文本连接在一起。

content = soup_post.find("div", {"class": "article-text"}).text<br />

下面,让我们把它们放在同一个函数内看一下:

def extract_post_data(post_url):<br /> soup_post = parse_url(post_url)<br /> <br /> title = soup_post.find("h1", {"class": "article-title"}).text<br /> datetime = soup_post.find("header", {"class": "row sub-header"}).find("span")["datetime"]<br /> abstract = soup_post.find("h2", {"class": "article-intro"}).text<br /> content = soup_post.find("div", {"class": "article-text"}).text<br /> <br /> data = {<br /> "title": title,<br /> "datetime": datetime,<br /> "abstract": abstract,<br /> "content": content,<br /> "url": post_url<br /> }<br /> <br /> return data<br />

提取多个页面上的帖子URL

如果我们检查主页的源代码,会看到每个页面文章的标题:

可以看到,每10篇文章出现在1个post-style1 col-md-6标签下:

下面,提取每个页面的文章就很容易了:

url = "https://www.premiumbeautynews. ... %3Bbr />soup = parse_url(url)<br />section = soup.find("section", {"class": "content"})<br />posts = section.findAll("div", {"class": "post-style1 col-md-6"})<br />

然后,对于每个单独的帖子,我们可以提取URL,该URL出现在h4标签内部。

我们将使用此URL调用我们先前定义的函数extract_post_data。

uri = post.find("h4").find("a")["href"]<br />

分页

在给定页面上提取帖子后,需要转到下一页并重复相同的操作。

如果查看分页,需要点击“下一个”按钮:

到达最后一页后,此按钮变为无效。

换句话说,当下一个按钮处于有效状态时,就需要执行爬虫操作,移至下一页并重复该操作。当按钮变为无效状态时,该过程应停止。

总结此逻辑,这将转换为以下代码:

next_button = ""<br />posts_data = []<br />count = 1<br />base_url = 'https://www.premiumbeautynews.com/'<br /><br />while next_button is not None:<br /> print(f"page number : {count}")<br /><br /> soup = parse_url(url)<br /> section = soup.find("section", {"class": "content"})<br /> posts = section.findAll("div", {"class": "post-style1 col-md-6"})<br /><br /> for post in tqdm_notebook(posts, leave=False):<br /> uri = post.find("h4").find("a")["href"]<br /> post_url = base_url + uri<br /> data = extract_post_data(post_url)<br /> posts_data.append(data)<br /> <br /> next_button = soup.find("p", {"class": "pagination"}).find("span", {"class": "next"})<br /> if next_button is not None:<br /> url = base_url + next_button.find("a")["href"]<br /> count += 1<br />

此循环完成后,将所有数据保存在posts_data中,可以将其转换为漂亮的DataFrames并导出为CSV或Excel文件。

df = pd.DataFrame(posts_data)<br />df.head()<br />

到这里,就把一个非结构化的网页转化成结构化的数据了!

往期精选

福利

最近我花费了半个月的时间,整理了1份理论+实践的计算机视觉入门教程,这或许是你见过最好的一份CV教程之一。独家打造、完全免费,需要的同学可以扫码添加我的个人微信,发送“CV”获取~

scrapy分页抓取网页 还在焦头烂额裸写Scrapy?这个神器让你90秒内配好一个爬虫

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2022-06-25 15:17

背景

爬虫是一件有趣的事情,让你可以通过爬虫程序自动化的将网上的信息抓取下来,免去了很多人工操作。在一些优质爬虫框架出来之前,开发者们还是通过简单的网络请求+网页解析器的方式来开发爬虫程序,例如 Python 的 requests + BeautifulSoup,高级一点的爬虫程序还会加入数据储存的模块,例如 MySQL、MongoDB。这种方式开发效率低,稳定性不佳,要开发好一个完备的、生产可用的爬虫可能需要好几个小时。我将这种方式称作 非框架爬虫。

2011 年,基于 Twisted 编写的 Scrapy 爬虫框架横空出世,突然被大众熟知,成为了首屈一指的全能的高性能爬虫异步框架。Scrapy 抽象出了几个核心模块,让开发者将主要注意力放在爬虫抓取逻辑上,而不用管数据下载、页面解析、任务调度等比较繁琐的模块。开发好一个生产可用的 Scrapy 爬虫,简单的可能只需要十几分钟,复杂的可能需要 1 小时以上。当然,我们还有其他很多优秀框架,例如 PySpider、Colly 等。我将这种爬虫称作 框架爬虫。框架爬虫解放了生产力,现在很多企业将框架爬虫改造后应用在生产环境中,大规模抓取数据。

然而,对于需要抓成百上千个网站的爬虫需求来说,框架爬虫可能就有些心有余而力不足了,编写爬虫成了体力活。例如,如果平均开发一个框架爬虫需要 20 分钟,如果一个全职爬虫开发工程师每天工作 8 个小时,那么开发 1000 个网站就需要 20000 分钟,333 个小时,42 个工作日,近 2 个月。当然,我们可以雇佣 10 个全职爬虫开发工程师,但这同样需要 4 个工作日才能完成(如下图)。

这同样是比较低效的。为了克服这个效率问题,可配置爬虫 应运而生。

可配置爬虫介绍

可配置爬虫(Configurable Spider) 正如其名字表示的,就是可以配置抓取规则的爬虫。可配置爬虫是一种高度抽象的爬虫程序,开发人员不用编写爬虫代码,只需要将需要抓取网页地址、字段、属性写在配置文件或数据库中,让特殊的爬虫程序根据配置去抓取数据。可配置爬虫将爬虫代码进一步抽象成了配置信息,简化了爬虫开发的流程。爬虫开发者只需要做相应的配置就可以完成爬虫的开发。因此,开发者可以通过可配置爬虫,大规模的编写爬虫程序(如下图)。

这样的方式让抓取成百上千的网站成了可能,一个熟练的爬虫配置员一天可以配置 1000 个新闻网站的爬虫。这对于有舆情监控需求的企业来说非常重要,因为可配置爬虫提高了生产力,让单位工作时间成本降低,提升了开发效率,方便后续的舆情分析和人工智能产品开发。很多企业都是自己研发的可配置爬虫(可能叫法会有些不一样,但实质是一个东西),然后雇佣一些爬虫配置员专门负责配置爬虫。

市面上免费开源的可配置爬虫框架并不多。比较早的有微软大神崔庆才开发的 Gerapy,属于一个爬虫管理平台,能够根据配置规则生成 Scrapy 项目文件。另一个比较新的可配置爬虫框架是 Crawlab(其实 Crawlab 不是可配置爬虫框架,而是一个灵活度很高的爬虫管理平台),在 v0.4.0 中发布了可配置爬虫。另外还有一个基于 Golang 的开源框架 Ferret ,很有意思,编写爬虫跟写 SQL 一样简单。其他还有一些商业产品,但根据用户反馈后都觉得专业度不高,不能满足生产需求。

可配置爬虫的诞生,主要是爬虫的模式比较单一,无非就是列表页+详情页的组合(如下图),或者仅仅列表页。当然还有稍微复杂一点的通用爬虫,这些也可以通过规则配置来完成。

Crawlab 可配置爬虫

我们今天主要介绍的是 Crawlab 的可配置爬虫。我们之前在 这篇文章 中有所介绍,但并没有深入讲解如何应用到实战中。今天,我们着重讲解一下。如果对 Crawlabb 的可配置爬虫比较陌生,请参考可配置爬虫的 文档。

可配置爬虫实战

实战部分的所有案例是作者用 Crawlab 的 官方 Demo 平台 通过可配置爬虫功能编写并完成抓取的,涵盖了新闻、金融、汽车、书籍、视频、搜索引擎、程序员社区等领域(见下图)。下面将介绍其中的几个,所有例子均在 官方 Demo 平台 上,均可以注册账号登录查看。

百度(搜索 "Crawlab")

爬虫地址:#/spiders/5e27d055b8f9c90019f42a83

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: http://www.baidu.com/s?wd=crawlab<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: ""<br /> list_xpath: //*[contains(@class, "c-container")]<br /> page_css: ""<br /> page_xpath: //*[@id="page"]//a[@class="n"][last()]<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: ""<br /> xpath: .//h3/a<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: ""<br /> xpath: .//h3/a<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: ""<br /> xpath: .//*[@class="c-abstract"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

SegmentFault(最新文章)

爬虫地址:#/spiders/5e27d116b8f9c90019f42a87

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://segmentfault.com/newest<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .news-list > .news-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: h4.news__item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .news-img<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: .article-excerpt<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

亚马逊中国(搜索"手机")

爬虫地址:#/spiders/5e27e157b8f9c90019f42afb

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://www.amazon.cn/s%3Fk%3D ... %3Bbr />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .s-result-item<br /> list_xpath: ""<br /> page_css: .a-last > a<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: span.a-text-normal<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .a-link-normal<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: price<br /> css: ""<br /> xpath: .//*[@class="a-price-whole"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: price_fraction<br /> css: ""<br /> xpath: .//*[@class="a-price-fraction"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: img<br /> css: .s-image-square-aspect > img<br /> xpath: ""<br /> attr: src<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

V2ex

爬虫地址:#/spiders/5e27dd67b8f9c90019f42ad9

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://v2ex.com/<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .cell.item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: a.topic-link<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: a.topic-link<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: replies<br /> css: .count_livid<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="markdown_body"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> AUTOTHROTTLE_ENABLED: "true"<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/79.0.3945.117 Safari/537.36<br />

抓取结果

36氪

爬虫地址:#/spiders/5e27ec82b8f9c90019f42b59

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://36kr.com/information/web_news<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .kr-flow-article-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: .article-item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: body<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: abstract<br /> css: body<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: author<br /> css: .kr-flow-bar-author<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: time<br /> css: .kr-flow-bar-time<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="common-width content articleDetailContent kr-rich-text-wrapper"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

实战爬虫一览爬虫名称爬虫类别

百度

列表页+分页

SegmentFault

列表页

CSDN

列表页+分页+详情页

V2ex

列表页+详情页

纵横

列表页

亚马逊中国

列表页+分页

雪球网

列表页+详情页

汽车之家

列表页+分页

豆瓣读书

列表页

36氪

列表页+详情页

腾讯视频

列表页

总结

Crawlab 的可配置爬虫非常方便,让程序员可以快速配置出自己需要的爬虫。配置上述 11 个爬虫总共花费了作者不到 40 分钟的时间(考虑到有反爬调试在里面),其中几个比较简单的爬虫在 1-2 分钟不到就配置完成了。而且作者一行代码也没有写,所有配置均在界面上完成。而且,Crawlab 可配置爬虫不仅支持在界面上的配置,同时还支持编写一个 Yaml 文件 Spiderfile 来完成配置(其实,所有的配置均可以映射到 Spiderfile 中)。Crawlab 可配置爬虫是基于 Scrapy 的,因此支持 Scrapy 绝大多数特性,可以通过 设置 来配置可配置爬虫的扩展属性,包括 USER_AGENT、ROBOTSTXT_OBEY 等等。为什么要用 Crawlab 作为可配置爬虫的首选呢?因为 Crawlab 可配置爬虫不仅能够配置爬虫,还能享受 Crawlab 爬虫管理平台的核心功能,包括任务调度、任务监控、定时任务、日志管理、消息通知等实用功能。而在后续开发中,Crawlab 开发组还将不断完善可配置爬虫,让其支持更多的功能,包括动态内容、更多的引擎、CrawlSpider 的实现等等。

要注意的是,不遵守 robots.txt 可能会造成法律风险,本文的实战爬虫均为学习交流用,切勿作为生产环境,任何滥用者自行承担法律责任。

参考

如果您觉得 Crawlab 对您的日常开发或公司有帮助,请加作者微信 tikazyq1 并注明 "Crawlab",作者会将你拉入群。欢迎在 Github 上进行 star,以及,如果遇到任何问题,请随时在 Github 上提 issue。另外,欢迎您对 Crawlab 做开发贡献。 查看全部

scrapy分页抓取网页 还在焦头烂额裸写Scrapy?这个神器让你90秒内配好一个爬虫

背景

爬虫是一件有趣的事情,让你可以通过爬虫程序自动化的将网上的信息抓取下来,免去了很多人工操作。在一些优质爬虫框架出来之前,开发者们还是通过简单的网络请求+网页解析器的方式来开发爬虫程序,例如 Python 的 requests + BeautifulSoup,高级一点的爬虫程序还会加入数据储存的模块,例如 MySQL、MongoDB。这种方式开发效率低,稳定性不佳,要开发好一个完备的、生产可用的爬虫可能需要好几个小时。我将这种方式称作 非框架爬虫。

2011 年,基于 Twisted 编写的 Scrapy 爬虫框架横空出世,突然被大众熟知,成为了首屈一指的全能的高性能爬虫异步框架。Scrapy 抽象出了几个核心模块,让开发者将主要注意力放在爬虫抓取逻辑上,而不用管数据下载、页面解析、任务调度等比较繁琐的模块。开发好一个生产可用的 Scrapy 爬虫,简单的可能只需要十几分钟,复杂的可能需要 1 小时以上。当然,我们还有其他很多优秀框架,例如 PySpider、Colly 等。我将这种爬虫称作 框架爬虫。框架爬虫解放了生产力,现在很多企业将框架爬虫改造后应用在生产环境中,大规模抓取数据。

然而,对于需要抓成百上千个网站的爬虫需求来说,框架爬虫可能就有些心有余而力不足了,编写爬虫成了体力活。例如,如果平均开发一个框架爬虫需要 20 分钟,如果一个全职爬虫开发工程师每天工作 8 个小时,那么开发 1000 个网站就需要 20000 分钟,333 个小时,42 个工作日,近 2 个月。当然,我们可以雇佣 10 个全职爬虫开发工程师,但这同样需要 4 个工作日才能完成(如下图)。

这同样是比较低效的。为了克服这个效率问题,可配置爬虫 应运而生。

可配置爬虫介绍

可配置爬虫(Configurable Spider) 正如其名字表示的,就是可以配置抓取规则的爬虫。可配置爬虫是一种高度抽象的爬虫程序,开发人员不用编写爬虫代码,只需要将需要抓取网页地址、字段、属性写在配置文件或数据库中,让特殊的爬虫程序根据配置去抓取数据。可配置爬虫将爬虫代码进一步抽象成了配置信息,简化了爬虫开发的流程。爬虫开发者只需要做相应的配置就可以完成爬虫的开发。因此,开发者可以通过可配置爬虫,大规模的编写爬虫程序(如下图)。

这样的方式让抓取成百上千的网站成了可能,一个熟练的爬虫配置员一天可以配置 1000 个新闻网站的爬虫。这对于有舆情监控需求的企业来说非常重要,因为可配置爬虫提高了生产力,让单位工作时间成本降低,提升了开发效率,方便后续的舆情分析和人工智能产品开发。很多企业都是自己研发的可配置爬虫(可能叫法会有些不一样,但实质是一个东西),然后雇佣一些爬虫配置员专门负责配置爬虫。

市面上免费开源的可配置爬虫框架并不多。比较早的有微软大神崔庆才开发的 Gerapy,属于一个爬虫管理平台,能够根据配置规则生成 Scrapy 项目文件。另一个比较新的可配置爬虫框架是 Crawlab(其实 Crawlab 不是可配置爬虫框架,而是一个灵活度很高的爬虫管理平台),在 v0.4.0 中发布了可配置爬虫。另外还有一个基于 Golang 的开源框架 Ferret ,很有意思,编写爬虫跟写 SQL 一样简单。其他还有一些商业产品,但根据用户反馈后都觉得专业度不高,不能满足生产需求。

可配置爬虫的诞生,主要是爬虫的模式比较单一,无非就是列表页+详情页的组合(如下图),或者仅仅列表页。当然还有稍微复杂一点的通用爬虫,这些也可以通过规则配置来完成。

Crawlab 可配置爬虫

我们今天主要介绍的是 Crawlab 的可配置爬虫。我们之前在 这篇文章 中有所介绍,但并没有深入讲解如何应用到实战中。今天,我们着重讲解一下。如果对 Crawlabb 的可配置爬虫比较陌生,请参考可配置爬虫的 文档。

可配置爬虫实战

实战部分的所有案例是作者用 Crawlab 的 官方 Demo 平台 通过可配置爬虫功能编写并完成抓取的,涵盖了新闻、金融、汽车、书籍、视频、搜索引擎、程序员社区等领域(见下图)。下面将介绍其中的几个,所有例子均在 官方 Demo 平台 上,均可以注册账号登录查看。

百度(搜索 "Crawlab")

爬虫地址:#/spiders/5e27d055b8f9c90019f42a83

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: http://www.baidu.com/s?wd=crawlab<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: ""<br /> list_xpath: //*[contains(@class, "c-container")]<br /> page_css: ""<br /> page_xpath: //*[@id="page"]//a[@class="n"][last()]<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: ""<br /> xpath: .//h3/a<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: ""<br /> xpath: .//h3/a<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: ""<br /> xpath: .//*[@class="c-abstract"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

SegmentFault(最新文章)

爬虫地址:#/spiders/5e27d116b8f9c90019f42a87

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://segmentfault.com/newest<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .news-list > .news-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: h4.news__item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .news-img<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: .article-excerpt<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

亚马逊中国(搜索"手机")

爬虫地址:#/spiders/5e27e157b8f9c90019f42afb

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://www.amazon.cn/s%3Fk%3D ... %3Bbr />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .s-result-item<br /> list_xpath: ""<br /> page_css: .a-last > a<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: span.a-text-normal<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .a-link-normal<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: price<br /> css: ""<br /> xpath: .//*[@class="a-price-whole"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: price_fraction<br /> css: ""<br /> xpath: .//*[@class="a-price-fraction"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: img<br /> css: .s-image-square-aspect > img<br /> xpath: ""<br /> attr: src<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

V2ex

爬虫地址:#/spiders/5e27dd67b8f9c90019f42ad9

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://v2ex.com/<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .cell.item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: a.topic-link<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: a.topic-link<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: replies<br /> css: .count_livid<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="markdown_body"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> AUTOTHROTTLE_ENABLED: "true"<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/79.0.3945.117 Safari/537.36<br />

抓取结果

36氪

爬虫地址:#/spiders/5e27ec82b8f9c90019f42b59

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://36kr.com/information/web_news<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .kr-flow-article-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: .article-item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: body<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: abstract<br /> css: body<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: author<br /> css: .kr-flow-bar-author<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: time<br /> css: .kr-flow-bar-time<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="common-width content articleDetailContent kr-rich-text-wrapper"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

实战爬虫一览爬虫名称爬虫类别

百度

列表页+分页

SegmentFault

列表页

CSDN

列表页+分页+详情页

V2ex

列表页+详情页

纵横

列表页

亚马逊中国

列表页+分页

雪球网

列表页+详情页

汽车之家

列表页+分页

豆瓣读书

列表页

36氪

列表页+详情页

腾讯视频

列表页

总结

Crawlab 的可配置爬虫非常方便,让程序员可以快速配置出自己需要的爬虫。配置上述 11 个爬虫总共花费了作者不到 40 分钟的时间(考虑到有反爬调试在里面),其中几个比较简单的爬虫在 1-2 分钟不到就配置完成了。而且作者一行代码也没有写,所有配置均在界面上完成。而且,Crawlab 可配置爬虫不仅支持在界面上的配置,同时还支持编写一个 Yaml 文件 Spiderfile 来完成配置(其实,所有的配置均可以映射到 Spiderfile 中)。Crawlab 可配置爬虫是基于 Scrapy 的,因此支持 Scrapy 绝大多数特性,可以通过 设置 来配置可配置爬虫的扩展属性,包括 USER_AGENT、ROBOTSTXT_OBEY 等等。为什么要用 Crawlab 作为可配置爬虫的首选呢?因为 Crawlab 可配置爬虫不仅能够配置爬虫,还能享受 Crawlab 爬虫管理平台的核心功能,包括任务调度、任务监控、定时任务、日志管理、消息通知等实用功能。而在后续开发中,Crawlab 开发组还将不断完善可配置爬虫,让其支持更多的功能,包括动态内容、更多的引擎、CrawlSpider 的实现等等。

要注意的是,不遵守 robots.txt 可能会造成法律风险,本文的实战爬虫均为学习交流用,切勿作为生产环境,任何滥用者自行承担法律责任。

参考

如果您觉得 Crawlab 对您的日常开发或公司有帮助,请加作者微信 tikazyq1 并注明 "Crawlab",作者会将你拉入群。欢迎在 Github 上进行 star,以及,如果遇到任何问题,请随时在 Github 上提 issue。另外,欢迎您对 Crawlab 做开发贡献。

scrapy分页抓取网页 还在焦头烂额裸写Scrapy?这个神器让你90秒内配好一个爬虫

网站优化 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2022-06-24 23:29

背景

爬虫是一件有趣的事情,让你可以通过爬虫程序自动化的将网上的信息抓取下来,免去了很多人工操作。在一些优质爬虫框架出来之前,开发者们还是通过简单的网络请求+网页解析器的方式来开发爬虫程序,例如 Python 的 requests + BeautifulSoup,高级一点的爬虫程序还会加入数据储存的模块,例如 MySQL、MongoDB。这种方式开发效率低,稳定性不佳,要开发好一个完备的、生产可用的爬虫可能需要好几个小时。我将这种方式称作 非框架爬虫。

2011 年,基于 Twisted 编写的 Scrapy 爬虫框架横空出世,突然被大众熟知,成为了首屈一指的全能的高性能爬虫异步框架。Scrapy 抽象出了几个核心模块,让开发者将主要注意力放在爬虫抓取逻辑上,而不用管数据下载、页面解析、任务调度等比较繁琐的模块。开发好一个生产可用的 Scrapy 爬虫,简单的可能只需要十几分钟,复杂的可能需要 1 小时以上。当然,我们还有其他很多优秀框架,例如 PySpider、Colly 等。我将这种爬虫称作 框架爬虫。框架爬虫解放了生产力,现在很多企业将框架爬虫改造后应用在生产环境中,大规模抓取数据。

然而,对于需要抓成百上千个网站的爬虫需求来说,框架爬虫可能就有些心有余而力不足了,编写爬虫成了体力活。例如,如果平均开发一个框架爬虫需要 20 分钟,如果一个全职爬虫开发工程师每天工作 8 个小时,那么开发 1000 个网站就需要 20000 分钟,333 个小时,42 个工作日,近 2 个月。当然,我们可以雇佣 10 个全职爬虫开发工程师,但这同样需要 4 个工作日才能完成(如下图)。

这同样是比较低效的。为了克服这个效率问题,可配置爬虫 应运而生。

可配置爬虫介绍

可配置爬虫(Configurable Spider) 正如其名字表示的,就是可以配置抓取规则的爬虫。可配置爬虫是一种高度抽象的爬虫程序,开发人员不用编写爬虫代码,只需要将需要抓取网页地址、字段、属性写在配置文件或数据库中,让特殊的爬虫程序根据配置去抓取数据。可配置爬虫将爬虫代码进一步抽象成了配置信息,简化了爬虫开发的流程。爬虫开发者只需要做相应的配置就可以完成爬虫的开发。因此,开发者可以通过可配置爬虫,大规模的编写爬虫程序(如下图)。

这样的方式让抓取成百上千的网站成了可能,一个熟练的爬虫配置员一天可以配置 1000 个新闻网站的爬虫。这对于有舆情监控需求的企业来说非常重要,因为可配置爬虫提高了生产力,让单位工作时间成本降低,提升了开发效率,方便后续的舆情分析和人工智能产品开发。很多企业都是自己研发的可配置爬虫(可能叫法会有些不一样,但实质是一个东西),然后雇佣一些爬虫配置员专门负责配置爬虫。

市面上免费开源的可配置爬虫框架并不多。比较早的有微软大神崔庆才开发的 Gerapy,属于一个爬虫管理平台,能够根据配置规则生成 Scrapy 项目文件。另一个比较新的可配置爬虫框架是 Crawlab(其实 Crawlab 不是可配置爬虫框架,而是一个灵活度很高的爬虫管理平台),在 v0.4.0 中发布了可配置爬虫。另外还有一个基于 Golang 的开源框架 Ferret ,很有意思,编写爬虫跟写 SQL 一样简单。其他还有一些商业产品,但根据用户反馈后都觉得专业度不高,不能满足生产需求。

可配置爬虫的诞生,主要是爬虫的模式比较单一,无非就是列表页+详情页的组合(如下图),或者仅仅列表页。当然还有稍微复杂一点的通用爬虫,这些也可以通过规则配置来完成。

Crawlab 可配置爬虫

我们今天主要介绍的是 Crawlab 的可配置爬虫。我们之前在 这篇文章 中有所介绍,但并没有深入讲解如何应用到实战中。今天,我们着重讲解一下。如果对 Crawlabb 的可配置爬虫比较陌生,请参考可配置爬虫的 文档。

可配置爬虫实战

实战部分的所有案例是作者用 Crawlab 的 官方 Demo 平台 通过可配置爬虫功能编写并完成抓取的,涵盖了新闻、金融、汽车、书籍、视频、搜索引擎、程序员社区等领域(见下图)。下面将介绍其中的几个,所有例子均在 官方 Demo 平台 上,均可以注册账号登录查看。

百度(搜索 "Crawlab")

爬虫地址:#/spiders/5e27d055b8f9c90019f42a83

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: http://www.baidu.com/s?wd=crawlab<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: ""<br /> list_xpath: //*[contains(@class, "c-container")]<br /> page_css: ""<br /> page_xpath: //*[@id="page"]//a[@class="n"][last()]<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: ""<br /> xpath: .//h3/a<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: ""<br /> xpath: .//h3/a<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: ""<br /> xpath: .//*[@class="c-abstract"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

SegmentFault(最新文章)

爬虫地址:#/spiders/5e27d116b8f9c90019f42a87

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://segmentfault.com/newest<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .news-list > .news-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: h4.news__item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .news-img<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: .article-excerpt<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

亚马逊中国(搜索"手机")

爬虫地址:#/spiders/5e27e157b8f9c90019f42afb

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://www.amazon.cn/s%3Fk%3D ... %3Bbr />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .s-result-item<br /> list_xpath: ""<br /> page_css: .a-last > a<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: span.a-text-normal<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .a-link-normal<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: price<br /> css: ""<br /> xpath: .//*[@class="a-price-whole"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: price_fraction<br /> css: ""<br /> xpath: .//*[@class="a-price-fraction"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: img<br /> css: .s-image-square-aspect > img<br /> xpath: ""<br /> attr: src<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

V2ex

爬虫地址:#/spiders/5e27dd67b8f9c90019f42ad9

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://v2ex.com/<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .cell.item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: a.topic-link<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: a.topic-link<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: replies<br /> css: .count_livid<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="markdown_body"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> AUTOTHROTTLE_ENABLED: "true"<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/79.0.3945.117 Safari/537.36<br />

抓取结果

36氪

爬虫地址:#/spiders/5e27ec82b8f9c90019f42b59

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://36kr.com/information/web_news<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .kr-flow-article-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: .article-item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: body<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: abstract<br /> css: body<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: author<br /> css: .kr-flow-bar-author<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: time<br /> css: .kr-flow-bar-time<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="common-width content articleDetailContent kr-rich-text-wrapper"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

实战爬虫一览爬虫名称爬虫类别

百度

列表页+分页

SegmentFault

列表页

CSDN

列表页+分页+详情页

V2ex

列表页+详情页

纵横

列表页

亚马逊中国

列表页+分页

雪球网

列表页+详情页

汽车之家

列表页+分页

豆瓣读书

列表页

36氪

列表页+详情页

腾讯视频

列表页

总结

Crawlab 的可配置爬虫非常方便,让程序员可以快速配置出自己需要的爬虫。配置上述 11 个爬虫总共花费了作者不到 40 分钟的时间(考虑到有反爬调试在里面),其中几个比较简单的爬虫在 1-2 分钟不到就配置完成了。而且作者一行代码也没有写,所有配置均在界面上完成。而且,Crawlab 可配置爬虫不仅支持在界面上的配置,同时还支持编写一个 Yaml 文件 Spiderfile 来完成配置(其实,所有的配置均可以映射到 Spiderfile 中)。Crawlab 可配置爬虫是基于 Scrapy 的,因此支持 Scrapy 绝大多数特性,可以通过 设置 来配置可配置爬虫的扩展属性,包括 USER_AGENT、ROBOTSTXT_OBEY 等等。为什么要用 Crawlab 作为可配置爬虫的首选呢?因为 Crawlab 可配置爬虫不仅能够配置爬虫,还能享受 Crawlab 爬虫管理平台的核心功能,包括任务调度、任务监控、定时任务、日志管理、消息通知等实用功能。而在后续开发中,Crawlab 开发组还将不断完善可配置爬虫,让其支持更多的功能,包括动态内容、更多的引擎、CrawlSpider 的实现等等。

要注意的是,不遵守 robots.txt 可能会造成法律风险,本文的实战爬虫均为学习交流用,切勿作为生产环境,任何滥用者自行承担法律责任。

参考

如果您觉得 Crawlab 对您的日常开发或公司有帮助,请加作者微信 tikazyq1 并注明 "Crawlab",作者会将你拉入群。欢迎在 Github 上进行 star,以及,如果遇到任何问题,请随时在 Github 上提 issue。另外,欢迎您对 Crawlab 做开发贡献。 查看全部

scrapy分页抓取网页 还在焦头烂额裸写Scrapy?这个神器让你90秒内配好一个爬虫

背景

爬虫是一件有趣的事情,让你可以通过爬虫程序自动化的将网上的信息抓取下来,免去了很多人工操作。在一些优质爬虫框架出来之前,开发者们还是通过简单的网络请求+网页解析器的方式来开发爬虫程序,例如 Python 的 requests + BeautifulSoup,高级一点的爬虫程序还会加入数据储存的模块,例如 MySQL、MongoDB。这种方式开发效率低,稳定性不佳,要开发好一个完备的、生产可用的爬虫可能需要好几个小时。我将这种方式称作 非框架爬虫。

2011 年,基于 Twisted 编写的 Scrapy 爬虫框架横空出世,突然被大众熟知,成为了首屈一指的全能的高性能爬虫异步框架。Scrapy 抽象出了几个核心模块,让开发者将主要注意力放在爬虫抓取逻辑上,而不用管数据下载、页面解析、任务调度等比较繁琐的模块。开发好一个生产可用的 Scrapy 爬虫,简单的可能只需要十几分钟,复杂的可能需要 1 小时以上。当然,我们还有其他很多优秀框架,例如 PySpider、Colly 等。我将这种爬虫称作 框架爬虫。框架爬虫解放了生产力,现在很多企业将框架爬虫改造后应用在生产环境中,大规模抓取数据。

然而,对于需要抓成百上千个网站的爬虫需求来说,框架爬虫可能就有些心有余而力不足了,编写爬虫成了体力活。例如,如果平均开发一个框架爬虫需要 20 分钟,如果一个全职爬虫开发工程师每天工作 8 个小时,那么开发 1000 个网站就需要 20000 分钟,333 个小时,42 个工作日,近 2 个月。当然,我们可以雇佣 10 个全职爬虫开发工程师,但这同样需要 4 个工作日才能完成(如下图)。

这同样是比较低效的。为了克服这个效率问题,可配置爬虫 应运而生。

可配置爬虫介绍

可配置爬虫(Configurable Spider) 正如其名字表示的,就是可以配置抓取规则的爬虫。可配置爬虫是一种高度抽象的爬虫程序,开发人员不用编写爬虫代码,只需要将需要抓取网页地址、字段、属性写在配置文件或数据库中,让特殊的爬虫程序根据配置去抓取数据。可配置爬虫将爬虫代码进一步抽象成了配置信息,简化了爬虫开发的流程。爬虫开发者只需要做相应的配置就可以完成爬虫的开发。因此,开发者可以通过可配置爬虫,大规模的编写爬虫程序(如下图)。

这样的方式让抓取成百上千的网站成了可能,一个熟练的爬虫配置员一天可以配置 1000 个新闻网站的爬虫。这对于有舆情监控需求的企业来说非常重要,因为可配置爬虫提高了生产力,让单位工作时间成本降低,提升了开发效率,方便后续的舆情分析和人工智能产品开发。很多企业都是自己研发的可配置爬虫(可能叫法会有些不一样,但实质是一个东西),然后雇佣一些爬虫配置员专门负责配置爬虫。

市面上免费开源的可配置爬虫框架并不多。比较早的有微软大神崔庆才开发的 Gerapy,属于一个爬虫管理平台,能够根据配置规则生成 Scrapy 项目文件。另一个比较新的可配置爬虫框架是 Crawlab(其实 Crawlab 不是可配置爬虫框架,而是一个灵活度很高的爬虫管理平台),在 v0.4.0 中发布了可配置爬虫。另外还有一个基于 Golang 的开源框架 Ferret ,很有意思,编写爬虫跟写 SQL 一样简单。其他还有一些商业产品,但根据用户反馈后都觉得专业度不高,不能满足生产需求。

可配置爬虫的诞生,主要是爬虫的模式比较单一,无非就是列表页+详情页的组合(如下图),或者仅仅列表页。当然还有稍微复杂一点的通用爬虫,这些也可以通过规则配置来完成。

Crawlab 可配置爬虫

我们今天主要介绍的是 Crawlab 的可配置爬虫。我们之前在 这篇文章 中有所介绍,但并没有深入讲解如何应用到实战中。今天,我们着重讲解一下。如果对 Crawlabb 的可配置爬虫比较陌生,请参考可配置爬虫的 文档。

可配置爬虫实战

实战部分的所有案例是作者用 Crawlab 的 官方 Demo 平台 通过可配置爬虫功能编写并完成抓取的,涵盖了新闻、金融、汽车、书籍、视频、搜索引擎、程序员社区等领域(见下图)。下面将介绍其中的几个,所有例子均在 官方 Demo 平台 上,均可以注册账号登录查看。

百度(搜索 "Crawlab")

爬虫地址:#/spiders/5e27d055b8f9c90019f42a83

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: http://www.baidu.com/s?wd=crawlab<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: ""<br /> list_xpath: //*[contains(@class, "c-container")]<br /> page_css: ""<br /> page_xpath: //*[@id="page"]//a[@class="n"][last()]<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: ""<br /> xpath: .//h3/a<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: ""<br /> xpath: .//h3/a<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: ""<br /> xpath: .//*[@class="c-abstract"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

SegmentFault(最新文章)

爬虫地址:#/spiders/5e27d116b8f9c90019f42a87

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://segmentfault.com/newest<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .news-list > .news-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: h4.news__item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .news-img<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: .article-excerpt<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

亚马逊中国(搜索"手机")

爬虫地址:#/spiders/5e27e157b8f9c90019f42afb

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://www.amazon.cn/s%3Fk%3D ... %3Bbr />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .s-result-item<br /> list_xpath: ""<br /> page_css: .a-last > a<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: span.a-text-normal<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .a-link-normal<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: price<br /> css: ""<br /> xpath: .//*[@class="a-price-whole"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: price_fraction<br /> css: ""<br /> xpath: .//*[@class="a-price-fraction"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: img<br /> css: .s-image-square-aspect > img<br /> xpath: ""<br /> attr: src<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

V2ex

爬虫地址:#/spiders/5e27dd67b8f9c90019f42ad9

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://v2ex.com/<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .cell.item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: a.topic-link<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: a.topic-link<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: replies<br /> css: .count_livid<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="markdown_body"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> AUTOTHROTTLE_ENABLED: "true"<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/79.0.3945.117 Safari/537.36<br />

抓取结果

36氪

爬虫地址:#/spiders/5e27ec82b8f9c90019f42b59

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://36kr.com/information/web_news<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .kr-flow-article-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: .article-item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: body<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: abstract<br /> css: body<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: author<br /> css: .kr-flow-bar-author<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: time<br /> css: .kr-flow-bar-time<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="common-width content articleDetailContent kr-rich-text-wrapper"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

实战爬虫一览爬虫名称爬虫类别

百度

列表页+分页

SegmentFault

列表页

CSDN

列表页+分页+详情页

V2ex

列表页+详情页

纵横

列表页

亚马逊中国

列表页+分页

雪球网

列表页+详情页

汽车之家

列表页+分页

豆瓣读书

列表页

36氪

列表页+详情页

腾讯视频

列表页

总结

Crawlab 的可配置爬虫非常方便,让程序员可以快速配置出自己需要的爬虫。配置上述 11 个爬虫总共花费了作者不到 40 分钟的时间(考虑到有反爬调试在里面),其中几个比较简单的爬虫在 1-2 分钟不到就配置完成了。而且作者一行代码也没有写,所有配置均在界面上完成。而且,Crawlab 可配置爬虫不仅支持在界面上的配置,同时还支持编写一个 Yaml 文件 Spiderfile 来完成配置(其实,所有的配置均可以映射到 Spiderfile 中)。Crawlab 可配置爬虫是基于 Scrapy 的,因此支持 Scrapy 绝大多数特性,可以通过 设置 来配置可配置爬虫的扩展属性,包括 USER_AGENT、ROBOTSTXT_OBEY 等等。为什么要用 Crawlab 作为可配置爬虫的首选呢?因为 Crawlab 可配置爬虫不仅能够配置爬虫,还能享受 Crawlab 爬虫管理平台的核心功能,包括任务调度、任务监控、定时任务、日志管理、消息通知等实用功能。而在后续开发中,Crawlab 开发组还将不断完善可配置爬虫,让其支持更多的功能,包括动态内容、更多的引擎、CrawlSpider 的实现等等。

要注意的是,不遵守 robots.txt 可能会造成法律风险,本文的实战爬虫均为学习交流用,切勿作为生产环境,任何滥用者自行承担法律责任。

参考

如果您觉得 Crawlab 对您的日常开发或公司有帮助,请加作者微信 tikazyq1 并注明 "Crawlab",作者会将你拉入群。欢迎在 Github 上进行 star,以及,如果遇到任何问题,请随时在 Github 上提 issue。另外,欢迎您对 Crawlab 做开发贡献。

scrapy分页抓取网页 还在焦头烂额裸写Scrapy?这个神器让你90秒内配好一个爬虫

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-06-23 19:10

背景

爬虫是一件有趣的事情,让你可以通过爬虫程序自动化的将网上的信息抓取下来,免去了很多人工操作。在一些优质爬虫框架出来之前,开发者们还是通过简单的网络请求+网页解析器的方式来开发爬虫程序,例如 Python 的 requests + BeautifulSoup,高级一点的爬虫程序还会加入数据储存的模块,例如 MySQL、MongoDB。这种方式开发效率低,稳定性不佳,要开发好一个完备的、生产可用的爬虫可能需要好几个小时。我将这种方式称作 非框架爬虫。

2011 年,基于 Twisted 编写的 Scrapy 爬虫框架横空出世,突然被大众熟知,成为了首屈一指的全能的高性能爬虫异步框架。Scrapy 抽象出了几个核心模块,让开发者将主要注意力放在爬虫抓取逻辑上,而不用管数据下载、页面解析、任务调度等比较繁琐的模块。开发好一个生产可用的 Scrapy 爬虫,简单的可能只需要十几分钟,复杂的可能需要 1 小时以上。当然,我们还有其他很多优秀框架,例如 PySpider、Colly 等。我将这种爬虫称作 框架爬虫。框架爬虫解放了生产力,现在很多企业将框架爬虫改造后应用在生产环境中,大规模抓取数据。

然而,对于需要抓成百上千个网站的爬虫需求来说,框架爬虫可能就有些心有余而力不足了,编写爬虫成了体力活。例如,如果平均开发一个框架爬虫需要 20 分钟,如果一个全职爬虫开发工程师每天工作 8 个小时,那么开发 1000 个网站就需要 20000 分钟,333 个小时,42 个工作日,近 2 个月。当然,我们可以雇佣 10 个全职爬虫开发工程师,但这同样需要 4 个工作日才能完成(如下图)。

这同样是比较低效的。为了克服这个效率问题,可配置爬虫 应运而生。

可配置爬虫介绍

可配置爬虫(Configurable Spider) 正如其名字表示的,就是可以配置抓取规则的爬虫。可配置爬虫是一种高度抽象的爬虫程序,开发人员不用编写爬虫代码,只需要将需要抓取网页地址、字段、属性写在配置文件或数据库中,让特殊的爬虫程序根据配置去抓取数据。可配置爬虫将爬虫代码进一步抽象成了配置信息,简化了爬虫开发的流程。爬虫开发者只需要做相应的配置就可以完成爬虫的开发。因此,开发者可以通过可配置爬虫,大规模的编写爬虫程序(如下图)。

这样的方式让抓取成百上千的网站成了可能,一个熟练的爬虫配置员一天可以配置 1000 个新闻网站的爬虫。这对于有舆情监控需求的企业来说非常重要,因为可配置爬虫提高了生产力,让单位工作时间成本降低,提升了开发效率,方便后续的舆情分析和人工智能产品开发。很多企业都是自己研发的可配置爬虫(可能叫法会有些不一样,但实质是一个东西),然后雇佣一些爬虫配置员专门负责配置爬虫。

市面上免费开源的可配置爬虫框架并不多。比较早的有微软大神崔庆才开发的 Gerapy,属于一个爬虫管理平台,能够根据配置规则生成 Scrapy 项目文件。另一个比较新的可配置爬虫框架是 Crawlab(其实 Crawlab 不是可配置爬虫框架,而是一个灵活度很高的爬虫管理平台),在 v0.4.0 中发布了可配置爬虫。另外还有一个基于 Golang 的开源框架 Ferret ,很有意思,编写爬虫跟写 SQL 一样简单。其他还有一些商业产品,但根据用户反馈后都觉得专业度不高,不能满足生产需求。

可配置爬虫的诞生,主要是爬虫的模式比较单一,无非就是列表页+详情页的组合(如下图),或者仅仅列表页。当然还有稍微复杂一点的通用爬虫,这些也可以通过规则配置来完成。

Crawlab 可配置爬虫

我们今天主要介绍的是 Crawlab 的可配置爬虫。我们之前在 这篇文章 中有所介绍,但并没有深入讲解如何应用到实战中。今天,我们着重讲解一下。如果对 Crawlabb 的可配置爬虫比较陌生,请参考可配置爬虫的 文档。

可配置爬虫实战

实战部分的所有案例是作者用 Crawlab 的 官方 Demo 平台 通过可配置爬虫功能编写并完成抓取的,涵盖了新闻、金融、汽车、书籍、视频、搜索引擎、程序员社区等领域(见下图)。下面将介绍其中的几个,所有例子均在 官方 Demo 平台 上,均可以注册账号登录查看。

百度(搜索 "Crawlab")

爬虫地址:#/spiders/5e27d055b8f9c90019f42a83

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: http://www.baidu.com/s?wd=crawlab<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: ""<br /> list_xpath: //*[contains(@class, "c-container")]<br /> page_css: ""<br /> page_xpath: //*[@id="page"]//a[@class="n"][last()]<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: ""<br /> xpath: .//h3/a<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: ""<br /> xpath: .//h3/a<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: ""<br /> xpath: .//*[@class="c-abstract"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

SegmentFault(最新文章)

爬虫地址:#/spiders/5e27d116b8f9c90019f42a87

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://segmentfault.com/newest<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .news-list > .news-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: h4.news__item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .news-img<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: .article-excerpt<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

亚马逊中国(搜索"手机")

爬虫地址:#/spiders/5e27e157b8f9c90019f42afb

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://www.amazon.cn/s%3Fk%3D ... %3Bbr />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .s-result-item<br /> list_xpath: ""<br /> page_css: .a-last > a<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: span.a-text-normal<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .a-link-normal<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: price<br /> css: ""<br /> xpath: .//*[@class="a-price-whole"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: price_fraction<br /> css: ""<br /> xpath: .//*[@class="a-price-fraction"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: img<br /> css: .s-image-square-aspect > img<br /> xpath: ""<br /> attr: src<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

V2ex

爬虫地址:#/spiders/5e27dd67b8f9c90019f42ad9

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://v2ex.com/<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .cell.item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: a.topic-link<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: a.topic-link<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: replies<br /> css: .count_livid<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="markdown_body"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> AUTOTHROTTLE_ENABLED: "true"<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/79.0.3945.117 Safari/537.36<br />

抓取结果

36氪

爬虫地址:#/spiders/5e27ec82b8f9c90019f42b59

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://36kr.com/information/web_news<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .kr-flow-article-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: .article-item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: body<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: abstract<br /> css: body<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: author<br /> css: .kr-flow-bar-author<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: time<br /> css: .kr-flow-bar-time<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="common-width content articleDetailContent kr-rich-text-wrapper"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

实战爬虫一览爬虫名称爬虫类别

百度

列表页+分页

SegmentFault

列表页

CSDN

列表页+分页+详情页

V2ex

列表页+详情页

纵横

列表页

亚马逊中国

列表页+分页

雪球网

列表页+详情页

汽车之家

列表页+分页

豆瓣读书

列表页

36氪

列表页+详情页

腾讯视频

列表页

总结

Crawlab 的可配置爬虫非常方便,让程序员可以快速配置出自己需要的爬虫。配置上述 11 个爬虫总共花费了作者不到 40 分钟的时间(考虑到有反爬调试在里面),其中几个比较简单的爬虫在 1-2 分钟不到就配置完成了。而且作者一行代码也没有写,所有配置均在界面上完成。而且,Crawlab 可配置爬虫不仅支持在界面上的配置,同时还支持编写一个 Yaml 文件 Spiderfile 来完成配置(其实,所有的配置均可以映射到 Spiderfile 中)。Crawlab 可配置爬虫是基于 Scrapy 的,因此支持 Scrapy 绝大多数特性,可以通过 设置 来配置可配置爬虫的扩展属性,包括 USER_AGENT、ROBOTSTXT_OBEY 等等。为什么要用 Crawlab 作为可配置爬虫的首选呢?因为 Crawlab 可配置爬虫不仅能够配置爬虫,还能享受 Crawlab 爬虫管理平台的核心功能,包括任务调度、任务监控、定时任务、日志管理、消息通知等实用功能。而在后续开发中,Crawlab 开发组还将不断完善可配置爬虫,让其支持更多的功能,包括动态内容、更多的引擎、CrawlSpider 的实现等等。

要注意的是,不遵守 robots.txt 可能会造成法律风险,本文的实战爬虫均为学习交流用,切勿作为生产环境,任何滥用者自行承担法律责任。

参考

如果您觉得 Crawlab 对您的日常开发或公司有帮助,请加作者微信 tikazyq1 并注明 "Crawlab",作者会将你拉入群。欢迎在 Github 上进行 star,以及,如果遇到任何问题,请随时在 Github 上提 issue。另外,欢迎您对 Crawlab 做开发贡献。 查看全部

scrapy分页抓取网页 还在焦头烂额裸写Scrapy?这个神器让你90秒内配好一个爬虫

背景

爬虫是一件有趣的事情,让你可以通过爬虫程序自动化的将网上的信息抓取下来,免去了很多人工操作。在一些优质爬虫框架出来之前,开发者们还是通过简单的网络请求+网页解析器的方式来开发爬虫程序,例如 Python 的 requests + BeautifulSoup,高级一点的爬虫程序还会加入数据储存的模块,例如 MySQL、MongoDB。这种方式开发效率低,稳定性不佳,要开发好一个完备的、生产可用的爬虫可能需要好几个小时。我将这种方式称作 非框架爬虫。

2011 年,基于 Twisted 编写的 Scrapy 爬虫框架横空出世,突然被大众熟知,成为了首屈一指的全能的高性能爬虫异步框架。Scrapy 抽象出了几个核心模块,让开发者将主要注意力放在爬虫抓取逻辑上,而不用管数据下载、页面解析、任务调度等比较繁琐的模块。开发好一个生产可用的 Scrapy 爬虫,简单的可能只需要十几分钟,复杂的可能需要 1 小时以上。当然,我们还有其他很多优秀框架,例如 PySpider、Colly 等。我将这种爬虫称作 框架爬虫。框架爬虫解放了生产力,现在很多企业将框架爬虫改造后应用在生产环境中,大规模抓取数据。

然而,对于需要抓成百上千个网站的爬虫需求来说,框架爬虫可能就有些心有余而力不足了,编写爬虫成了体力活。例如,如果平均开发一个框架爬虫需要 20 分钟,如果一个全职爬虫开发工程师每天工作 8 个小时,那么开发 1000 个网站就需要 20000 分钟,333 个小时,42 个工作日,近 2 个月。当然,我们可以雇佣 10 个全职爬虫开发工程师,但这同样需要 4 个工作日才能完成(如下图)。

这同样是比较低效的。为了克服这个效率问题,可配置爬虫 应运而生。

可配置爬虫介绍

可配置爬虫(Configurable Spider) 正如其名字表示的,就是可以配置抓取规则的爬虫。可配置爬虫是一种高度抽象的爬虫程序,开发人员不用编写爬虫代码,只需要将需要抓取网页地址、字段、属性写在配置文件或数据库中,让特殊的爬虫程序根据配置去抓取数据。可配置爬虫将爬虫代码进一步抽象成了配置信息,简化了爬虫开发的流程。爬虫开发者只需要做相应的配置就可以完成爬虫的开发。因此,开发者可以通过可配置爬虫,大规模的编写爬虫程序(如下图)。

这样的方式让抓取成百上千的网站成了可能,一个熟练的爬虫配置员一天可以配置 1000 个新闻网站的爬虫。这对于有舆情监控需求的企业来说非常重要,因为可配置爬虫提高了生产力,让单位工作时间成本降低,提升了开发效率,方便后续的舆情分析和人工智能产品开发。很多企业都是自己研发的可配置爬虫(可能叫法会有些不一样,但实质是一个东西),然后雇佣一些爬虫配置员专门负责配置爬虫。

市面上免费开源的可配置爬虫框架并不多。比较早的有微软大神崔庆才开发的 Gerapy,属于一个爬虫管理平台,能够根据配置规则生成 Scrapy 项目文件。另一个比较新的可配置爬虫框架是 Crawlab(其实 Crawlab 不是可配置爬虫框架,而是一个灵活度很高的爬虫管理平台),在 v0.4.0 中发布了可配置爬虫。另外还有一个基于 Golang 的开源框架 Ferret ,很有意思,编写爬虫跟写 SQL 一样简单。其他还有一些商业产品,但根据用户反馈后都觉得专业度不高,不能满足生产需求。

可配置爬虫的诞生,主要是爬虫的模式比较单一,无非就是列表页+详情页的组合(如下图),或者仅仅列表页。当然还有稍微复杂一点的通用爬虫,这些也可以通过规则配置来完成。

Crawlab 可配置爬虫

我们今天主要介绍的是 Crawlab 的可配置爬虫。我们之前在 这篇文章 中有所介绍,但并没有深入讲解如何应用到实战中。今天,我们着重讲解一下。如果对 Crawlabb 的可配置爬虫比较陌生,请参考可配置爬虫的 文档。

可配置爬虫实战

实战部分的所有案例是作者用 Crawlab 的 官方 Demo 平台 通过可配置爬虫功能编写并完成抓取的,涵盖了新闻、金融、汽车、书籍、视频、搜索引擎、程序员社区等领域(见下图)。下面将介绍其中的几个,所有例子均在 官方 Demo 平台 上,均可以注册账号登录查看。

百度(搜索 "Crawlab")

爬虫地址:#/spiders/5e27d055b8f9c90019f42a83

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: http://www.baidu.com/s?wd=crawlab<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: ""<br /> list_xpath: //*[contains(@class, "c-container")]<br /> page_css: ""<br /> page_xpath: //*[@id="page"]//a[@class="n"][last()]<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: ""<br /> xpath: .//h3/a<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: ""<br /> xpath: .//h3/a<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: ""<br /> xpath: .//*[@class="c-abstract"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

SegmentFault(最新文章)

爬虫地址:#/spiders/5e27d116b8f9c90019f42a87

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://segmentfault.com/newest<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .news-list > .news-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: h4.news__item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .news-img<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: .article-excerpt<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

亚马逊中国(搜索"手机")

爬虫地址:#/spiders/5e27e157b8f9c90019f42afb

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://www.amazon.cn/s%3Fk%3D ... %3Bbr />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .s-result-item<br /> list_xpath: ""<br /> page_css: .a-last > a<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: span.a-text-normal<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .a-link-normal<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: price<br /> css: ""<br /> xpath: .//*[@class="a-price-whole"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: price_fraction<br /> css: ""<br /> xpath: .//*[@class="a-price-fraction"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: img<br /> css: .s-image-square-aspect > img<br /> xpath: ""<br /> attr: src<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

V2ex

爬虫地址:#/spiders/5e27dd67b8f9c90019f42ad9

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://v2ex.com/<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .cell.item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: a.topic-link<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: a.topic-link<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: replies<br /> css: .count_livid<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="markdown_body"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> AUTOTHROTTLE_ENABLED: "true"<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/79.0.3945.117 Safari/537.36<br />

抓取结果

36氪

爬虫地址:#/spiders/5e27ec82b8f9c90019f42b59

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://36kr.com/information/web_news<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .kr-flow-article-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: .article-item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: body<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: abstract<br /> css: body<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: author<br /> css: .kr-flow-bar-author<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: time<br /> css: .kr-flow-bar-time<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="common-width content articleDetailContent kr-rich-text-wrapper"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

实战爬虫一览爬虫名称爬虫类别

百度

列表页+分页

SegmentFault

列表页

CSDN

列表页+分页+详情页

V2ex

列表页+详情页

纵横

列表页

亚马逊中国

列表页+分页

雪球网

列表页+详情页

汽车之家

列表页+分页

豆瓣读书

列表页

36氪

列表页+详情页

腾讯视频

列表页

总结

Crawlab 的可配置爬虫非常方便,让程序员可以快速配置出自己需要的爬虫。配置上述 11 个爬虫总共花费了作者不到 40 分钟的时间(考虑到有反爬调试在里面),其中几个比较简单的爬虫在 1-2 分钟不到就配置完成了。而且作者一行代码也没有写,所有配置均在界面上完成。而且,Crawlab 可配置爬虫不仅支持在界面上的配置,同时还支持编写一个 Yaml 文件 Spiderfile 来完成配置(其实,所有的配置均可以映射到 Spiderfile 中)。Crawlab 可配置爬虫是基于 Scrapy 的,因此支持 Scrapy 绝大多数特性,可以通过 设置 来配置可配置爬虫的扩展属性,包括 USER_AGENT、ROBOTSTXT_OBEY 等等。为什么要用 Crawlab 作为可配置爬虫的首选呢?因为 Crawlab 可配置爬虫不仅能够配置爬虫,还能享受 Crawlab 爬虫管理平台的核心功能,包括任务调度、任务监控、定时任务、日志管理、消息通知等实用功能。而在后续开发中,Crawlab 开发组还将不断完善可配置爬虫,让其支持更多的功能,包括动态内容、更多的引擎、CrawlSpider 的实现等等。

要注意的是,不遵守 robots.txt 可能会造成法律风险,本文的实战爬虫均为学习交流用,切勿作为生产环境,任何滥用者自行承担法律责任。

参考

如果您觉得 Crawlab 对您的日常开发或公司有帮助,请加作者微信 tikazyq1 并注明 "Crawlab",作者会将你拉入群。欢迎在 Github 上进行 star,以及,如果遇到任何问题,请随时在 Github 上提 issue。另外,欢迎您对 Crawlab 做开发贡献。

scrapy分页抓取网页 还在焦头烂额裸写Scrapy?这个神器让你90秒内配好一个爬虫

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-06-22 03:09

背景

爬虫是一件有趣的事情,让你可以通过爬虫程序自动化的将网上的信息抓取下来,免去了很多人工操作。在一些优质爬虫框架出来之前,开发者们还是通过简单的网络请求+网页解析器的方式来开发爬虫程序,例如 Python 的 requests + BeautifulSoup,高级一点的爬虫程序还会加入数据储存的模块,例如 MySQL、MongoDB。这种方式开发效率低,稳定性不佳,要开发好一个完备的、生产可用的爬虫可能需要好几个小时。我将这种方式称作 非框架爬虫。

2011 年,基于 Twisted 编写的 Scrapy 爬虫框架横空出世,突然被大众熟知,成为了首屈一指的全能的高性能爬虫异步框架。Scrapy 抽象出了几个核心模块,让开发者将主要注意力放在爬虫抓取逻辑上,而不用管数据下载、页面解析、任务调度等比较繁琐的模块。开发好一个生产可用的 Scrapy 爬虫,简单的可能只需要十几分钟,复杂的可能需要 1 小时以上。当然,我们还有其他很多优秀框架,例如 PySpider、Colly 等。我将这种爬虫称作 框架爬虫。框架爬虫解放了生产力,现在很多企业将框架爬虫改造后应用在生产环境中,大规模抓取数据。

然而,对于需要抓成百上千个网站的爬虫需求来说,框架爬虫可能就有些心有余而力不足了,编写爬虫成了体力活。例如,如果平均开发一个框架爬虫需要 20 分钟,如果一个全职爬虫开发工程师每天工作 8 个小时,那么开发 1000 个网站就需要 20000 分钟,333 个小时,42 个工作日,近 2 个月。当然,我们可以雇佣 10 个全职爬虫开发工程师,但这同样需要 4 个工作日才能完成(如下图)。

这同样是比较低效的。为了克服这个效率问题,可配置爬虫 应运而生。

可配置爬虫介绍

可配置爬虫(Configurable Spider) 正如其名字表示的,就是可以配置抓取规则的爬虫。可配置爬虫是一种高度抽象的爬虫程序,开发人员不用编写爬虫代码,只需要将需要抓取网页地址、字段、属性写在配置文件或数据库中,让特殊的爬虫程序根据配置去抓取数据。可配置爬虫将爬虫代码进一步抽象成了配置信息,简化了爬虫开发的流程。爬虫开发者只需要做相应的配置就可以完成爬虫的开发。因此,开发者可以通过可配置爬虫,大规模的编写爬虫程序(如下图)。

这样的方式让抓取成百上千的网站成了可能,一个熟练的爬虫配置员一天可以配置 1000 个新闻网站的爬虫。这对于有舆情监控需求的企业来说非常重要,因为可配置爬虫提高了生产力,让单位工作时间成本降低,提升了开发效率,方便后续的舆情分析和人工智能产品开发。很多企业都是自己研发的可配置爬虫(可能叫法会有些不一样,但实质是一个东西),然后雇佣一些爬虫配置员专门负责配置爬虫。

市面上免费开源的可配置爬虫框架并不多。比较早的有微软大神崔庆才开发的 Gerapy,属于一个爬虫管理平台,能够根据配置规则生成 Scrapy 项目文件。另一个比较新的可配置爬虫框架是 Crawlab(其实 Crawlab 不是可配置爬虫框架,而是一个灵活度很高的爬虫管理平台),在 v0.4.0 中发布了可配置爬虫。另外还有一个基于 Golang 的开源框架 Ferret ,很有意思,编写爬虫跟写 SQL 一样简单。其他还有一些商业产品,但根据用户反馈后都觉得专业度不高,不能满足生产需求。

可配置爬虫的诞生,主要是爬虫的模式比较单一,无非就是列表页+详情页的组合(如下图),或者仅仅列表页。当然还有稍微复杂一点的通用爬虫,这些也可以通过规则配置来完成。

Crawlab 可配置爬虫

我们今天主要介绍的是 Crawlab 的可配置爬虫。我们之前在 这篇文章 中有所介绍,但并没有深入讲解如何应用到实战中。今天,我们着重讲解一下。如果对 Crawlabb 的可配置爬虫比较陌生,请参考可配置爬虫的 文档。

可配置爬虫实战

实战部分的所有案例是作者用 Crawlab 的 官方 Demo 平台 通过可配置爬虫功能编写并完成抓取的,涵盖了新闻、金融、汽车、书籍、视频、搜索引擎、程序员社区等领域(见下图)。下面将介绍其中的几个,所有例子均在 官方 Demo 平台 上,均可以注册账号登录查看。

百度(搜索 "Crawlab")

爬虫地址:#/spiders/5e27d055b8f9c90019f42a83

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: http://www.baidu.com/s?wd=crawlab<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: ""<br /> list_xpath: //*[contains(@class, "c-container")]<br /> page_css: ""<br /> page_xpath: //*[@id="page"]//a[@class="n"][last()]<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: ""<br /> xpath: .//h3/a<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: ""<br /> xpath: .//h3/a<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: ""<br /> xpath: .//*[@class="c-abstract"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

SegmentFault(最新文章)

爬虫地址:#/spiders/5e27d116b8f9c90019f42a87

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://segmentfault.com/newest<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .news-list > .news-item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: title<br /> css: h4.news__item-title<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .news-img<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: abstract<br /> css: .article-excerpt<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

亚马逊中国(搜索"手机")

爬虫地址:#/spiders/5e27e157b8f9c90019f42afb

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://www.amazon.cn/s%3Fk%3D ... %3Bbr />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .s-result-item<br /> list_xpath: ""<br /> page_css: .a-last > a<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: span.a-text-normal<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: .a-link-normal<br /> xpath: ""<br /> attr: href<br /> next_stage: ""<br /> remark: ""<br /> - name: price<br /> css: ""<br /> xpath: .//*[@class="a-price-whole"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: price_fraction<br /> css: ""<br /> xpath: .//*[@class="a-price-fraction"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: img<br /> css: .s-image-square-aspect > img<br /> xpath: ""<br /> attr: src<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/78.0.3904.108 Safari/537.36<br />

抓取结果

V2ex

爬虫地址:#/spiders/5e27dd67b8f9c90019f42ad9

爬虫配置

Spiderfile

version: 0.4.4<br />engine: scrapy<br />start_url: https://v2ex.com/<br />start_stage: list<br />stages:<br />- name: list<br /> is_list: true<br /> list_css: .cell.item<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: href<br /> fields:<br /> - name: title<br /> css: a.topic-link<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br /> - name: url<br /> css: a.topic-link<br /> xpath: ""<br /> attr: href<br /> next_stage: detail<br /> remark: ""<br /> - name: replies<br /> css: .count_livid<br /> xpath: ""<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />- name: detail<br /> is_list: false<br /> list_css: ""<br /> list_xpath: ""<br /> page_css: ""<br /> page_xpath: ""<br /> page_attr: ""<br /> fields:<br /> - name: content<br /> css: ""<br /> xpath: .//*[@class="markdown_body"]<br /> attr: ""<br /> next_stage: ""<br /> remark: ""<br />settings:<br /> AUTOTHROTTLE_ENABLED: "true"<br /> ROBOTSTXT_OBEY: "false"<br /> USER_AGENT: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_14_6) AppleWebKit/537.36 (KHTML,<br /> like Gecko) Chrome/79.0.3945.117 Safari/537.36<br />

抓取结果

36氪

爬虫地址:#/spiders/5e27ec82b8f9c90019f42b59

爬虫配置

Spiderfile