nodejs抓取动态网页

nodejs抓取动态网页( 响应设计分为数据结构数据结构设计和响应码设计(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-02-27 23:17

响应设计分为数据结构数据结构设计和响应码设计(组图)

)

分页获取部分博客

GET /api/blogs?page=1&size=15&sort=time

- 按层次组织资源:

// 获取某个博客下面的所有评论

GET /api/blogs/143/comments

层次化的设计有可能会让URL太长,不便于阅读,比如:

// 获取某个博客下面的某个评论的某个回复

GET /api/blogs/123/comments/12343/replys/2231

所以,我们也可以使用扁平化的方式设计所有的资源:

// 获取某个博客的所有评论,使用查询参数来限定条件

GET /api/comments?blogId=123

// 获取某个评论的所有回复

GET /api/replys?commentId=123

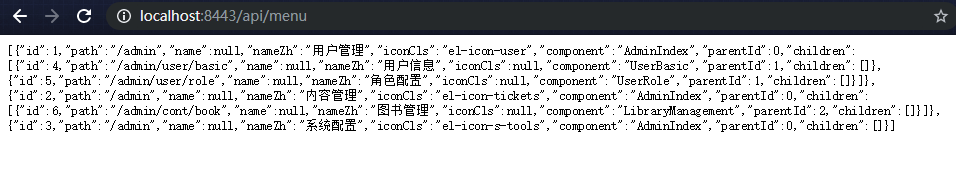

响应式设计

响应式设计分为数据结构设计和响应代码设计。

前后分离

在以前的时代,当用户请求一个网页时,服务器通过JSP技术或者其他模板引擎技术动态渲染,然后返回给用户。它们看起来像这样:

这样做的缺点是后端和前端是一体的,即使前端代码不是后端人员编写的,双方仍然需要进行必要的交流和沟通,减少了开发效率;并且前后端一起部署,灵活性差;而静态资源的后台处理性能较差,不应该处理静态资源压缩、缓存等问题,应该交给代理服务器,比如Nginx。

前后端分离最极端的方式是:前后端独立编写,独立部署,通过API接口交互。它们看起来像这样:

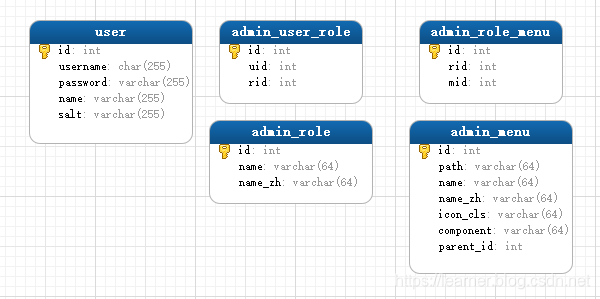

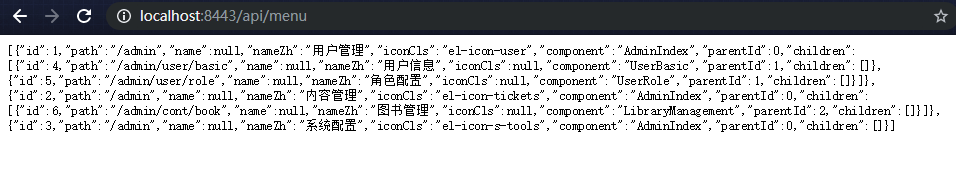

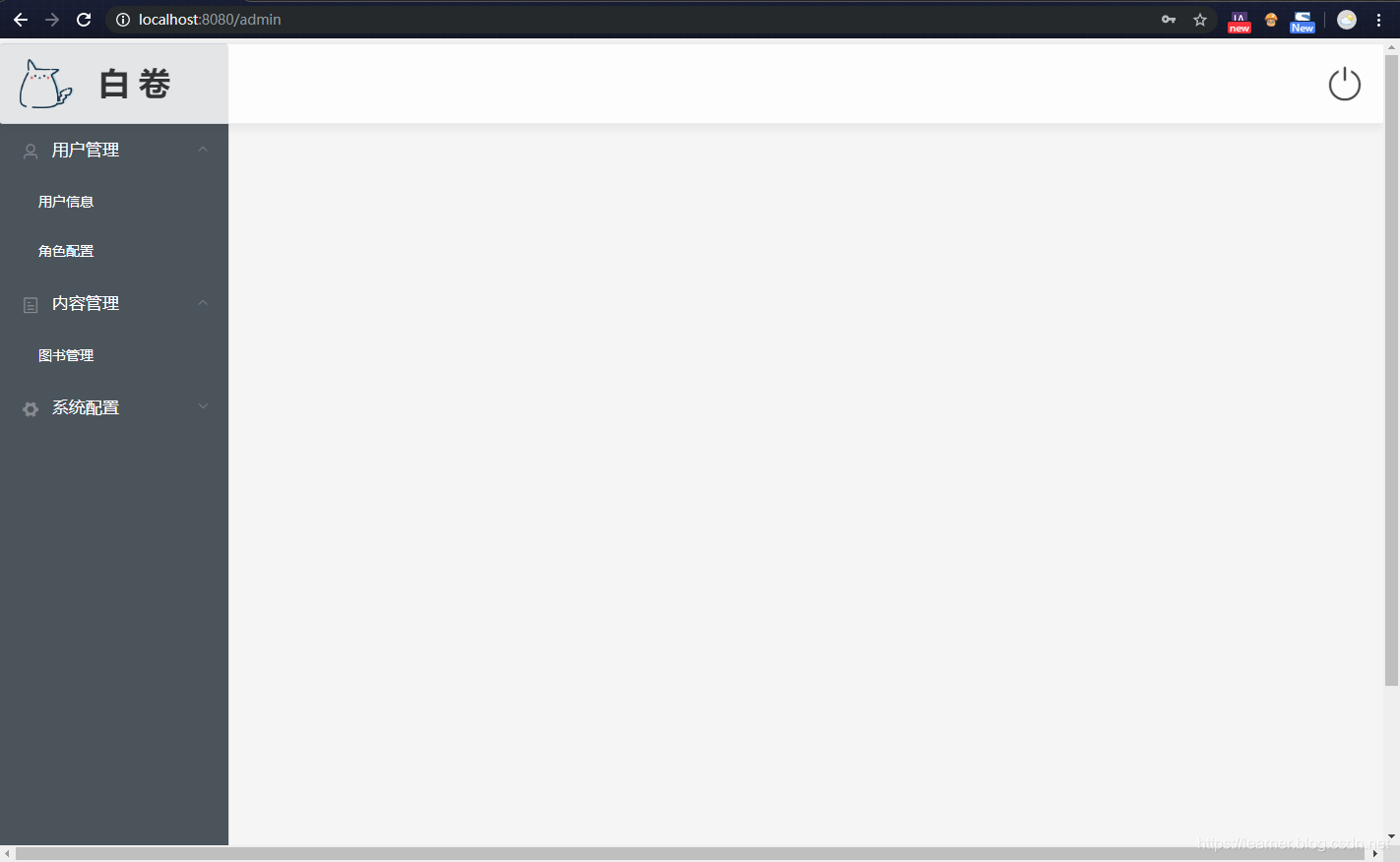

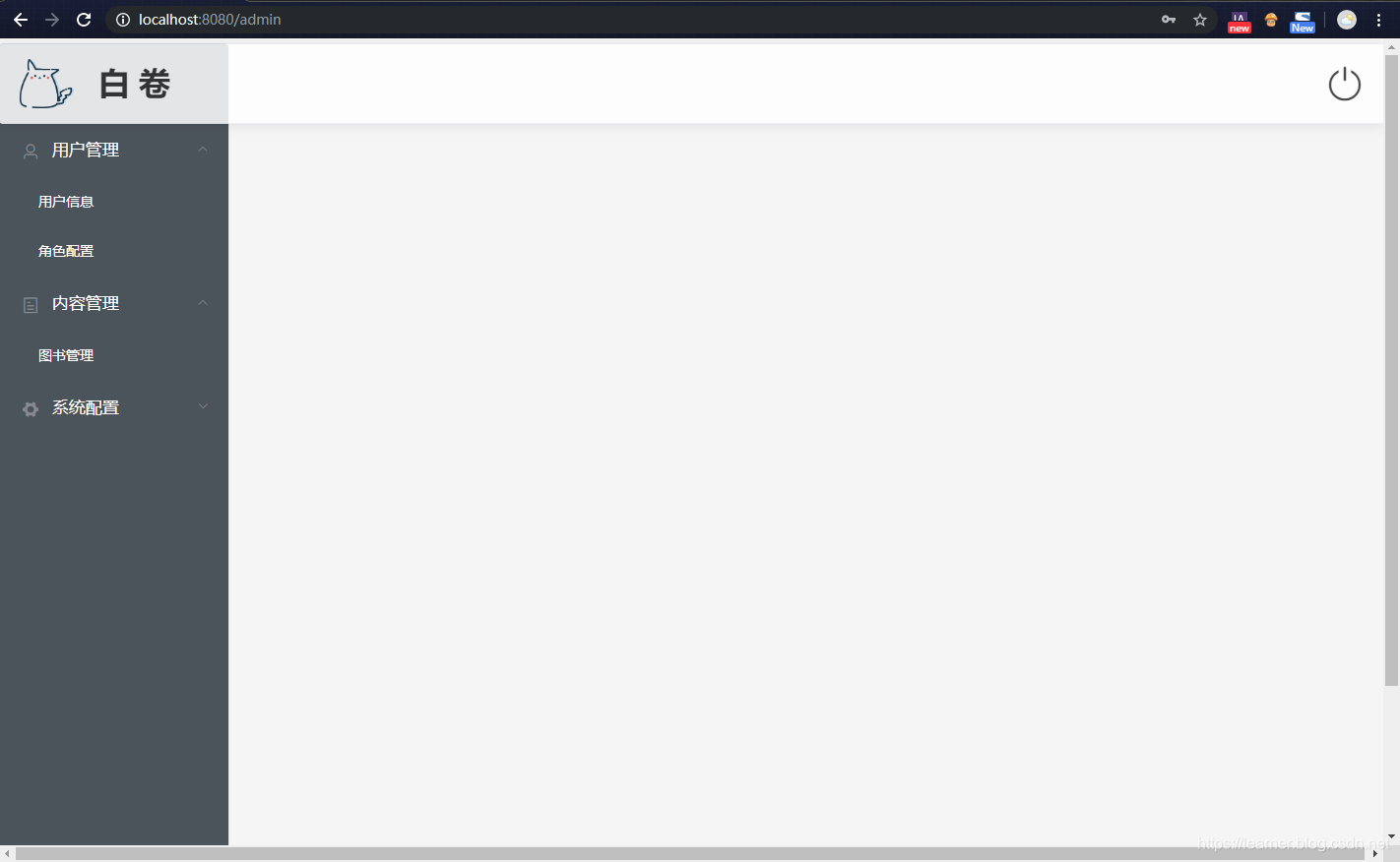

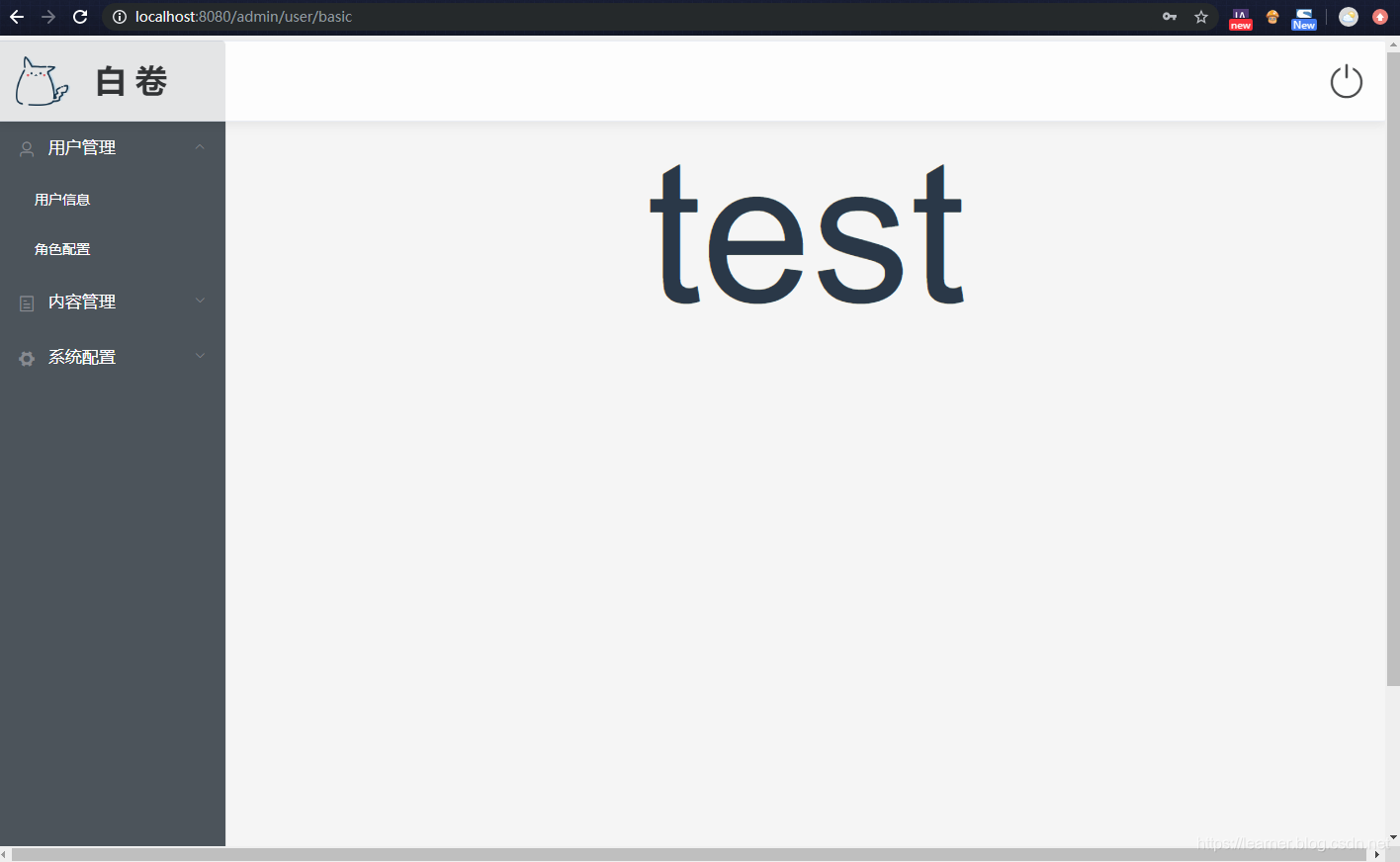

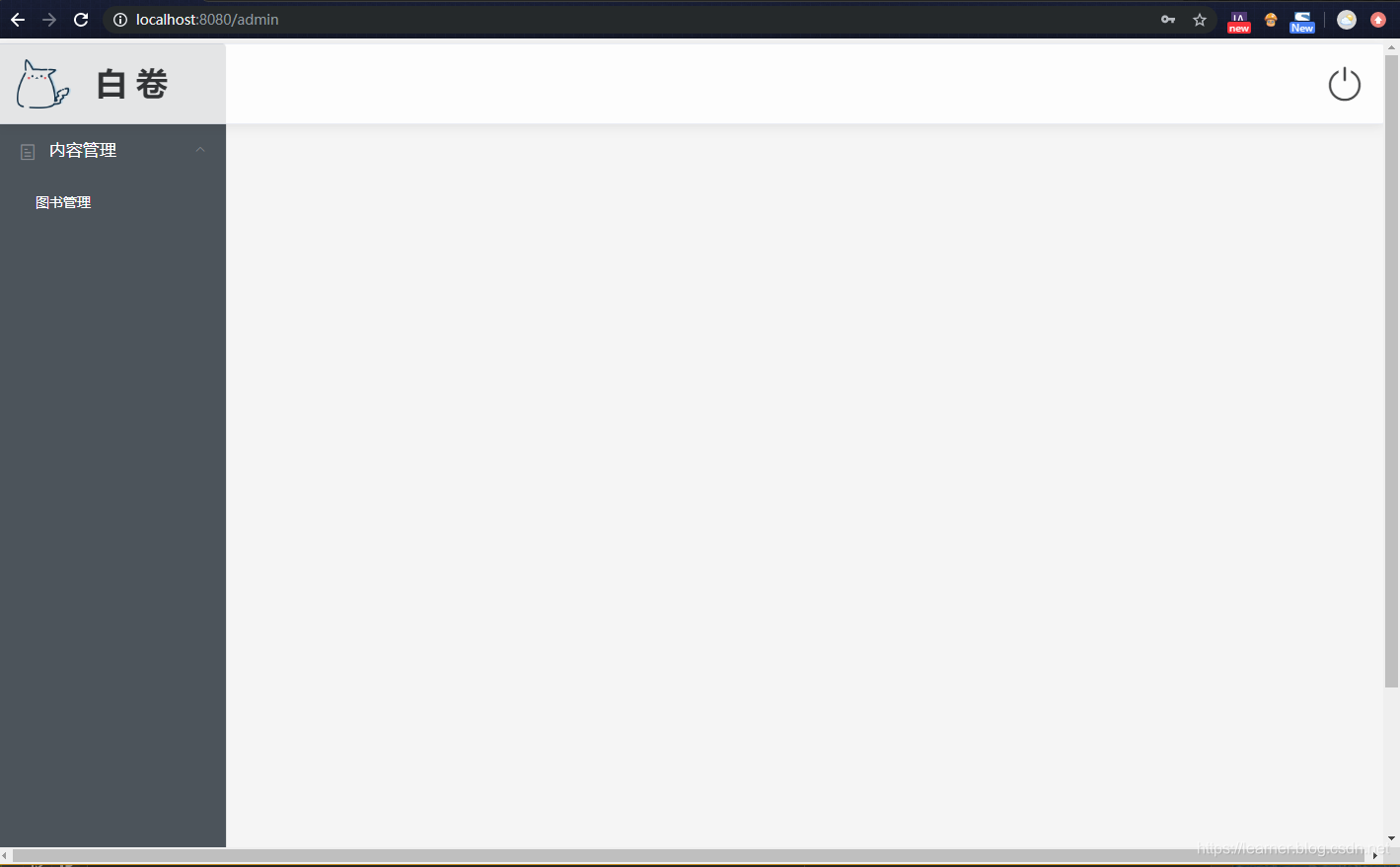

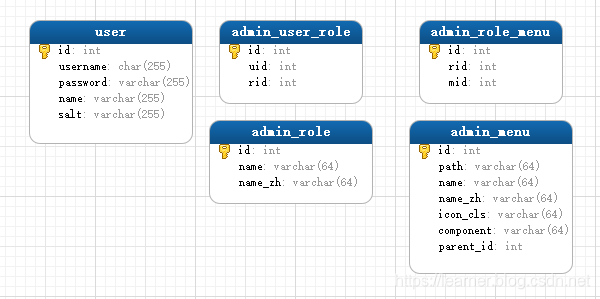

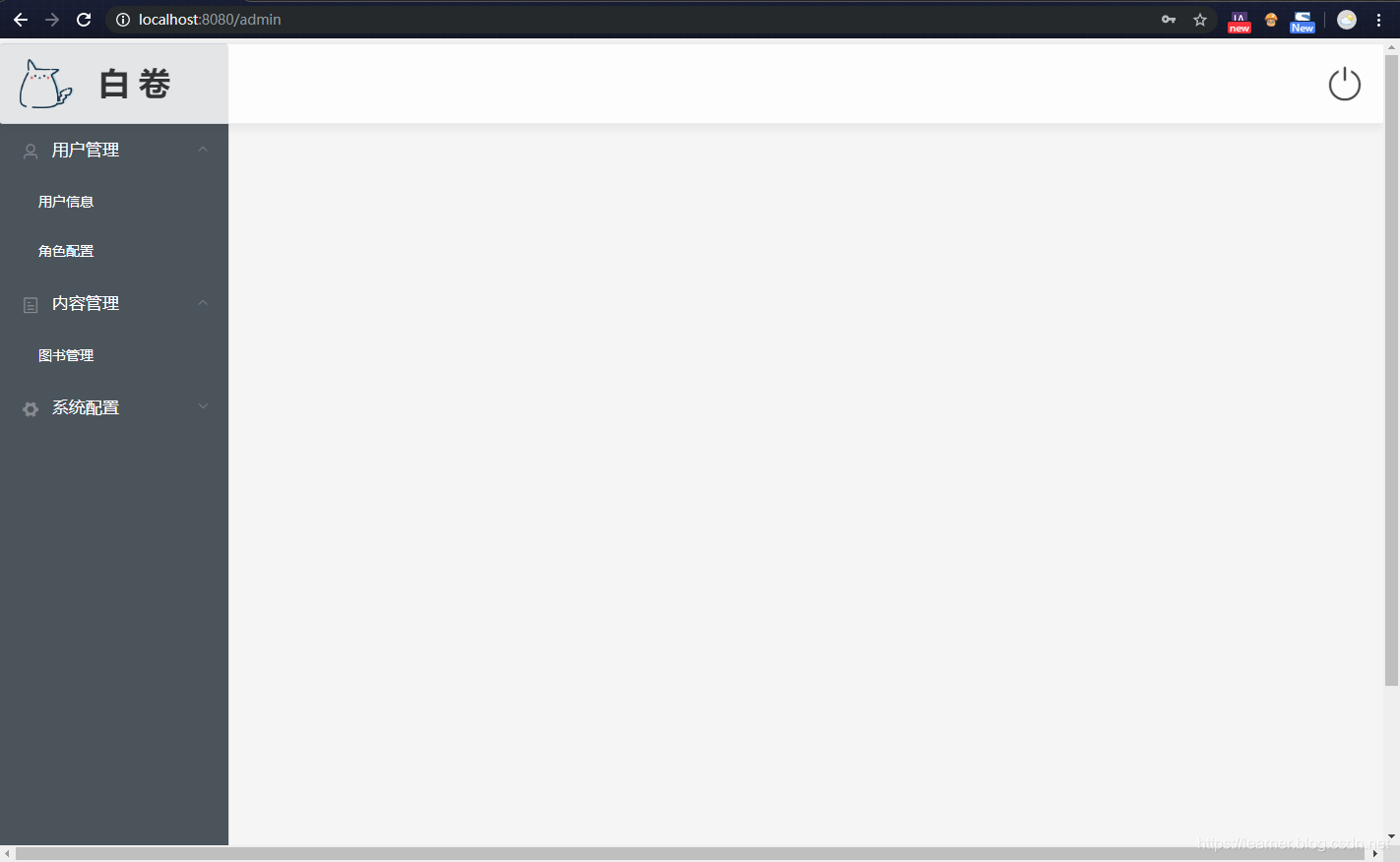

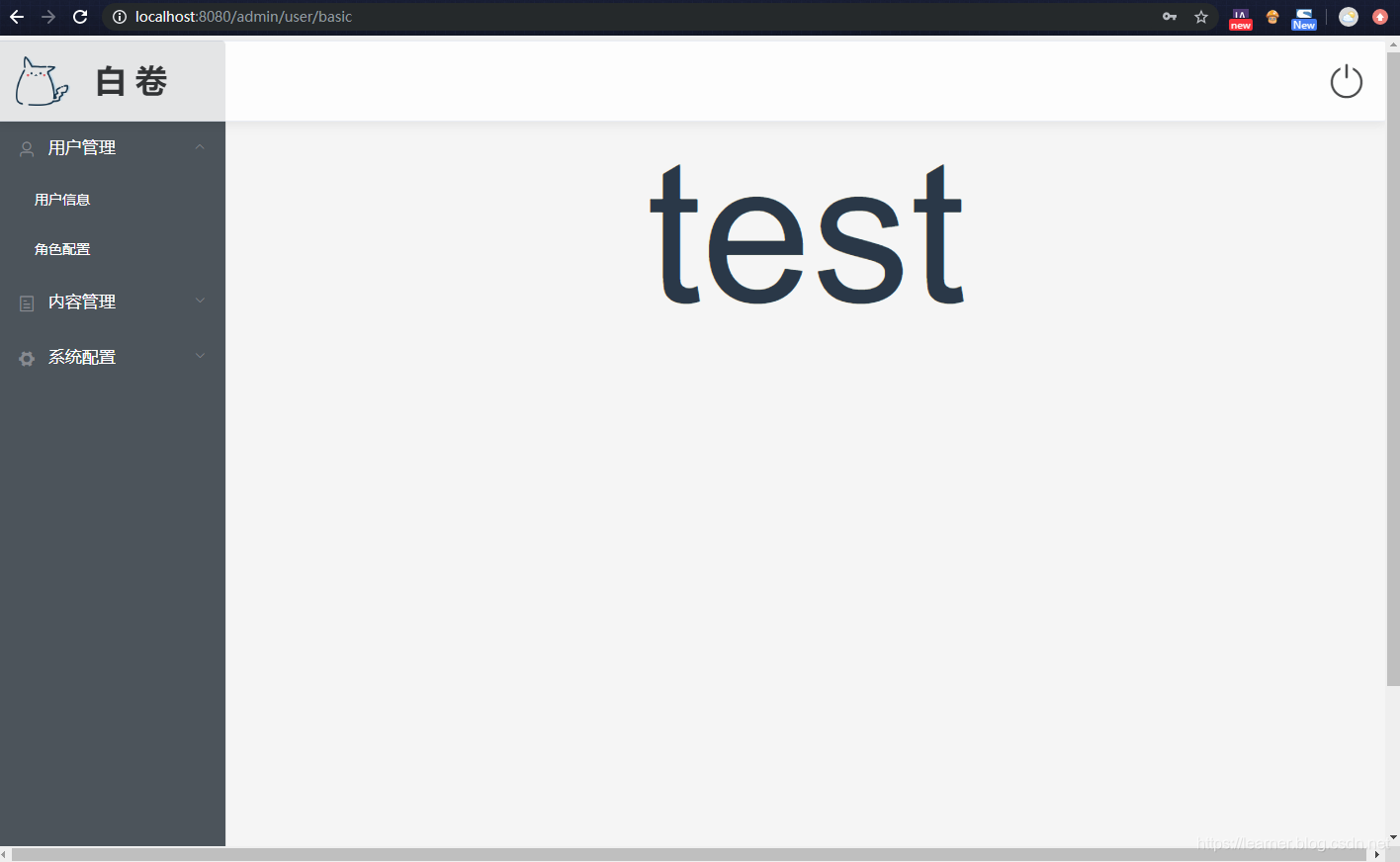

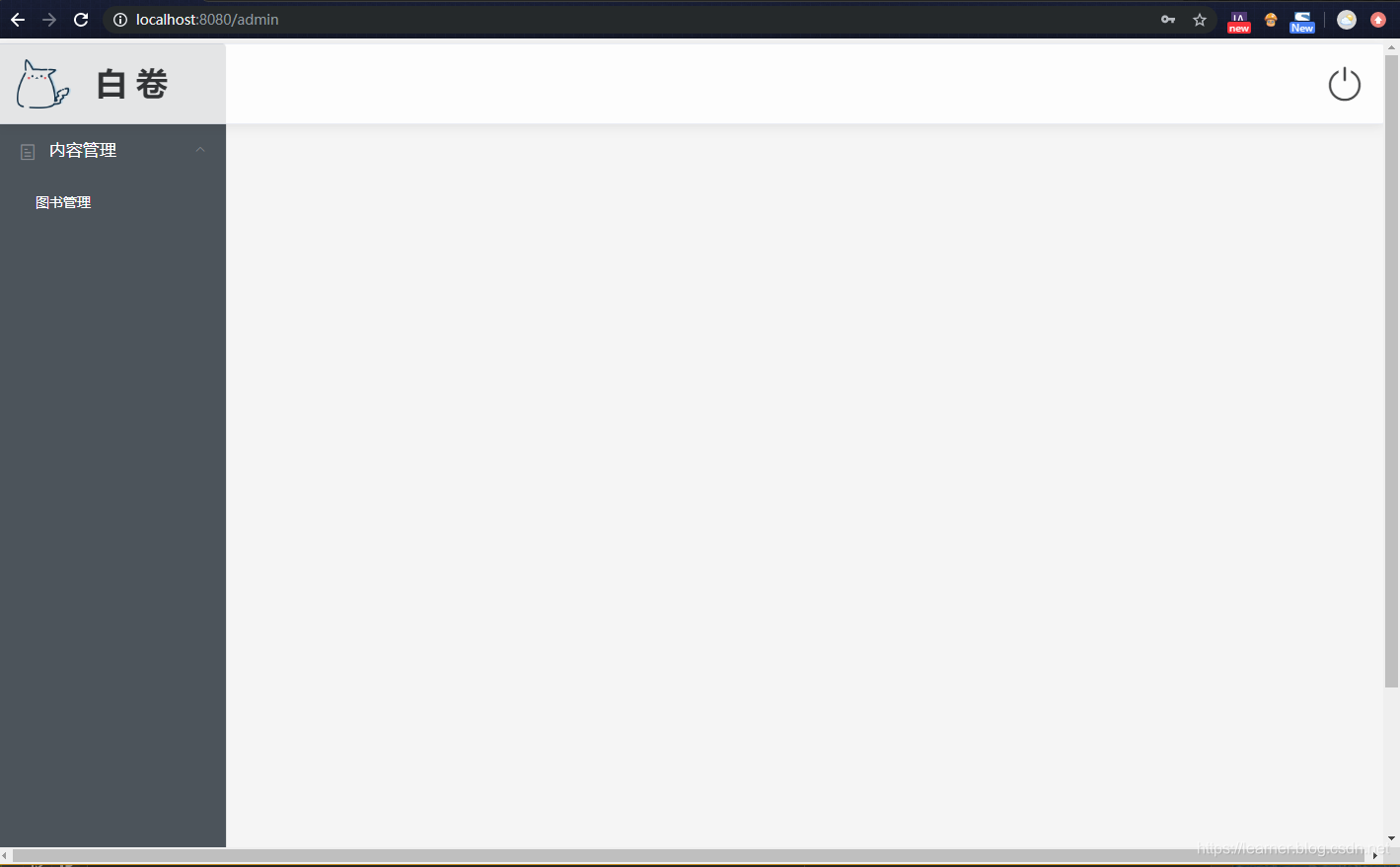

项目实战:电商管理后台

目标是为商家和管理员实现一个收录账户模块、权限模块、商品分类模块和订单模块的后台系统。

项目采用前后端分离的开发方式。它只实现 API 功能,不提供接口。

项目结构搭建及实施过程

在之前的TODO项目的基础上,增加了一个中间件包和一个测试包。前者用于存放中间件包,因为权限管理需要通过中间件来实现;后者是一个与测试相关的包。

各个模块的实现顺序为:模型层-->服务层-->路由器层。单元测试:服务层编写脚本测试;路由器层使用邮递员测试。配置文件的环境切换

开发环境和生产环境的配置一般是不同的,比如端口配置和数据库配置。一般我们通过环境变量NODE_ENV来区分。为了动态切换配置,需要根据NODE_ENV的当前值加载不同的配置对象。

这样做的方法是:

创建config目录,创建dev.js和prod.js存放对应的配置信息,编写index.js实现动态配置切换的逻辑。

目录结构:

写入入口文件

添加依赖项:

npm i body-parser express express-async-errors mongoose morgan

编写 app.js 和 db.js 文件。

应用程序.js

//引入dib

require('./db')

const config = require('./config');

const morgan = require('morgan')

const bodyParser = require('body-parser');

const express = require('express')

// 引入异常捕获处理

require('express-async-errors');

const app = express();

//注册中间件

// log中间件

app.use(morgan('combined'));

//注册自定义的中间件

// 注册body-parser中间件

// parse application/x-www-form-urlencoded

app.use(bodyParser.urlencoded({ extended: false }));

// parse application/json

app.use(bodyParser.json());

// 注册路由

app.use("/users", require('./router/account'));

// 注册异常处理中间件

app.use((err, req, res, next)=>{

res.fail(err.toString())

});

//启动

app.listen(config.PORT);

数据库.js

const config = require('./config');

const mongoose = require('mongoose');

mongoose.connect(`mongodb://127.0.0.1/${config.DB}`);

const db = mongoose.connection;

db.on('error', (err)=>{

console.log(err);

});

db.on("open", ()=>{

console.log("mongodb connect successfully!");

});

账户模块

先写模型,再写服务,最后写路由器;最后,测试服务和路由器。

REST 中间件

为了方便返回 REST 结果,我们编写了一个 res_md.js 中间件,用于为每个 res 对象安装 2 个方法。注意中间件的注册顺序要放在前面。代码显示如下:

module.exports = function (req, res, next) {

res.success = (data = null) =>{

res.send({

code: 0,

msg: "操作成功",

data: data

})

};

res.fail = (msg)=>{

res.send({

code: -1,

msg: msg

})

};

next();

};

账户模型

const mongoose = require('mongoose')

const schema = new mongoose.Schema({

username: {

type: String,

required: [true, "用户名不能缺少"]

},

password: {

type: String,

required: [true, "密码不能缺少"]

},

age: {

type: Number,

min: [0, "年龄不能小于0"],

max: [120, "年龄不能大于120"]

},

role: {

type: Number,

default: 0 // 0是商家, 10086是管理员

},

created:{

type: Date,

default: Date.now()

}

});

module.exports = mongoose.model('user', schema);

账户服务

const User = require('../model/user');

const config = require('../config')

const crypto = require('lxj-crypto')

/**

* 根据用户名获取某个用户

* @param username

* @returns {Promise}

*/

async function getUserByUsername(username) {

return await User.findOne({username: username}).select("-__v")

}

async function checkCanInsertUser(user) {

//检查密码是否为空

if(!user.password || user.password.length===0){

throw Error("密码不能为空")

}

//检查用户是否已经存在

let res = await getUserByUsername(user.username);

if(res){

throw Error("用户名已经存在")

}

}

/**

* 添加普通用户

* @param user

* @returns {Promise}

*/

async function addUser(user) {

await checkCanInsertUser(user);

user.role = 0;

user.created = Date.now();

//对密码进行加密,加密的方式:使用username作为随机数对password进行哈希

user.password = crypto.md5Hmac(user.password, user.username)

await User.create(user)

}

async function deleteUser(id) {

let res = await User.deleteOne({_id:id});

if(!res || res.n===0){

throw Error("删除用户失败")

}

}

/**

* 登录的方法

* @param user

* @returns token

*/

async function login(user) {

// 1. 对密码进行加密

user.password = crypto.md5Hmac(user.password, user.username)

// 2. 进行查询

let res = await User.findOne({username:user.username, password: user.password});

if(!res){

throw Error("用户名或者密码错误")

}

// 说明用户名和密码验证成功,需要生产token返回给客户端,以后客户端的header中带上这个token

// token 生产方法:用aes进行对指定的data加密

let tokenData = {

username: user.username,

expire: Date.now() + config.TokenDuration

};

let token = crypto.aesEncrypt(JSON.stringify(tokenData), config.TokenKey);

return token

}

module.exports = {

getUserByUsername,

addUser,

deleteUser,

login

};

帐号路由器

let router = require("express").Router();

let accountService = require('../service/accout')

router.get("/:username", async (req, res)=>{

let user = await accountService.getUserByUsername(req.params.username);

res.success(user);

});

// 登录

router.post("/login", async (req, res)=>{

let token = await accountService.login(req.body);

res.success({token});

});

// 注册

router.post("/register", async (req, res)=>{

await accountService.register(req.body)

res.success()

});

router.delete("/:id", async (req, res)=>{

await accountService.deleteUser(req.params.id)

res.success()

});

module.exports = router;

``` 查看全部

nodejs抓取动态网页(

响应设计分为数据结构数据结构设计和响应码设计(组图)

)

分页获取部分博客

GET /api/blogs?page=1&size=15&sort=time

- 按层次组织资源:

// 获取某个博客下面的所有评论

GET /api/blogs/143/comments

层次化的设计有可能会让URL太长,不便于阅读,比如:

// 获取某个博客下面的某个评论的某个回复

GET /api/blogs/123/comments/12343/replys/2231

所以,我们也可以使用扁平化的方式设计所有的资源:

// 获取某个博客的所有评论,使用查询参数来限定条件

GET /api/comments?blogId=123

// 获取某个评论的所有回复

GET /api/replys?commentId=123

响应式设计

响应式设计分为数据结构设计和响应代码设计。

前后分离

在以前的时代,当用户请求一个网页时,服务器通过JSP技术或者其他模板引擎技术动态渲染,然后返回给用户。它们看起来像这样:

这样做的缺点是后端和前端是一体的,即使前端代码不是后端人员编写的,双方仍然需要进行必要的交流和沟通,减少了开发效率;并且前后端一起部署,灵活性差;而静态资源的后台处理性能较差,不应该处理静态资源压缩、缓存等问题,应该交给代理服务器,比如Nginx。

前后端分离最极端的方式是:前后端独立编写,独立部署,通过API接口交互。它们看起来像这样:

项目实战:电商管理后台

目标是为商家和管理员实现一个收录账户模块、权限模块、商品分类模块和订单模块的后台系统。

项目采用前后端分离的开发方式。它只实现 API 功能,不提供接口。

项目结构搭建及实施过程

在之前的TODO项目的基础上,增加了一个中间件包和一个测试包。前者用于存放中间件包,因为权限管理需要通过中间件来实现;后者是一个与测试相关的包。

各个模块的实现顺序为:模型层-->服务层-->路由器层。单元测试:服务层编写脚本测试;路由器层使用邮递员测试。配置文件的环境切换

开发环境和生产环境的配置一般是不同的,比如端口配置和数据库配置。一般我们通过环境变量NODE_ENV来区分。为了动态切换配置,需要根据NODE_ENV的当前值加载不同的配置对象。

这样做的方法是:

创建config目录,创建dev.js和prod.js存放对应的配置信息,编写index.js实现动态配置切换的逻辑。

目录结构:

写入入口文件

添加依赖项:

npm i body-parser express express-async-errors mongoose morgan

编写 app.js 和 db.js 文件。

应用程序.js

//引入dib

require('./db')

const config = require('./config');

const morgan = require('morgan')

const bodyParser = require('body-parser');

const express = require('express')

// 引入异常捕获处理

require('express-async-errors');

const app = express();

//注册中间件

// log中间件

app.use(morgan('combined'));

//注册自定义的中间件

// 注册body-parser中间件

// parse application/x-www-form-urlencoded

app.use(bodyParser.urlencoded({ extended: false }));

// parse application/json

app.use(bodyParser.json());

// 注册路由

app.use("/users", require('./router/account'));

// 注册异常处理中间件

app.use((err, req, res, next)=>{

res.fail(err.toString())

});

//启动

app.listen(config.PORT);

数据库.js

const config = require('./config');

const mongoose = require('mongoose');

mongoose.connect(`mongodb://127.0.0.1/${config.DB}`);

const db = mongoose.connection;

db.on('error', (err)=>{

console.log(err);

});

db.on("open", ()=>{

console.log("mongodb connect successfully!");

});

账户模块

先写模型,再写服务,最后写路由器;最后,测试服务和路由器。

REST 中间件

为了方便返回 REST 结果,我们编写了一个 res_md.js 中间件,用于为每个 res 对象安装 2 个方法。注意中间件的注册顺序要放在前面。代码显示如下:

module.exports = function (req, res, next) {

res.success = (data = null) =>{

res.send({

code: 0,

msg: "操作成功",

data: data

})

};

res.fail = (msg)=>{

res.send({

code: -1,

msg: msg

})

};

next();

};

账户模型

const mongoose = require('mongoose')

const schema = new mongoose.Schema({

username: {

type: String,

required: [true, "用户名不能缺少"]

},

password: {

type: String,

required: [true, "密码不能缺少"]

},

age: {

type: Number,

min: [0, "年龄不能小于0"],

max: [120, "年龄不能大于120"]

},

role: {

type: Number,

default: 0 // 0是商家, 10086是管理员

},

created:{

type: Date,

default: Date.now()

}

});

module.exports = mongoose.model('user', schema);

账户服务

const User = require('../model/user');

const config = require('../config')

const crypto = require('lxj-crypto')

/**

* 根据用户名获取某个用户

* @param username

* @returns {Promise}

*/

async function getUserByUsername(username) {

return await User.findOne({username: username}).select("-__v")

}

async function checkCanInsertUser(user) {

//检查密码是否为空

if(!user.password || user.password.length===0){

throw Error("密码不能为空")

}

//检查用户是否已经存在

let res = await getUserByUsername(user.username);

if(res){

throw Error("用户名已经存在")

}

}

/**

* 添加普通用户

* @param user

* @returns {Promise}

*/

async function addUser(user) {

await checkCanInsertUser(user);

user.role = 0;

user.created = Date.now();

//对密码进行加密,加密的方式:使用username作为随机数对password进行哈希

user.password = crypto.md5Hmac(user.password, user.username)

await User.create(user)

}

async function deleteUser(id) {

let res = await User.deleteOne({_id:id});

if(!res || res.n===0){

throw Error("删除用户失败")

}

}

/**

* 登录的方法

* @param user

* @returns token

*/

async function login(user) {

// 1. 对密码进行加密

user.password = crypto.md5Hmac(user.password, user.username)

// 2. 进行查询

let res = await User.findOne({username:user.username, password: user.password});

if(!res){

throw Error("用户名或者密码错误")

}

// 说明用户名和密码验证成功,需要生产token返回给客户端,以后客户端的header中带上这个token

// token 生产方法:用aes进行对指定的data加密

let tokenData = {

username: user.username,

expire: Date.now() + config.TokenDuration

};

let token = crypto.aesEncrypt(JSON.stringify(tokenData), config.TokenKey);

return token

}

module.exports = {

getUserByUsername,

addUser,

deleteUser,

login

};

帐号路由器

let router = require("express").Router();

let accountService = require('../service/accout')

router.get("/:username", async (req, res)=>{

let user = await accountService.getUserByUsername(req.params.username);

res.success(user);

});

// 登录

router.post("/login", async (req, res)=>{

let token = await accountService.login(req.body);

res.success({token});

});

// 注册

router.post("/register", async (req, res)=>{

await accountService.register(req.body)

res.success()

});

router.delete("/:id", async (req, res)=>{

await accountService.deleteUser(req.params.id)

res.success()

});

module.exports = router;

```

nodejs抓取动态网页(Nodejs将JavaScript语言带到了服务器端(图)网络爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-02-22 10:08

Nodejs 将 JavaScript 语言带到了服务器端。Nodejs作为js主要用户的前端,已经获得了服务器端的开发能力,但是除了用express搭建博客,还能做哪些好玩的项目呢?你为什么不只是一个网络爬虫。据说互联网上90%以上的流量是由爬虫贡献的。不知道是真是假,但至少证明了爬虫被广泛使用,尤其是在电商比价领域。它做的是爬虫中的弱鸡,只实现基本功能,见底部代码。

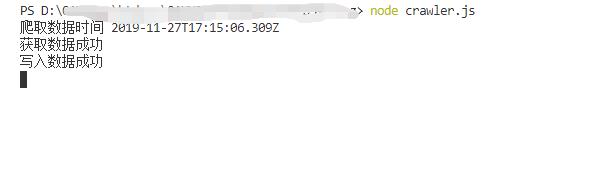

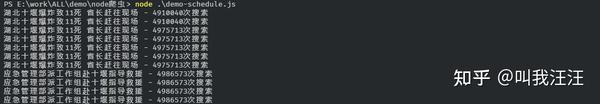

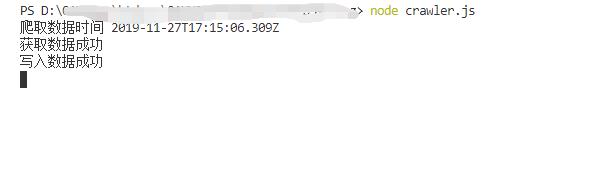

运行结果:

下面简要介绍实现过程。

先选择爬取对象,这里也是门槛比较低的新闻站,因为我每天早上都要去逛街,比较熟悉,为什么新闻站比较简单,因为通常是这种类型的网站不需要用户登录,所有爬虫请求都很容易伪造。

爬虫的基本思路是获取页面 -> 构造信息选择器 -> 分析页面链接 -> 获取相邻页面 -> 循环的第一步,对于新闻站来说,我们想要得到什么就是新闻内容,向页面请求html代码后,只要从页面中找到内容容器元素,就很容易得到新闻内容。下一步是获取相邻页面的地址。cnBeta新闻有上一页和下一页的链接,但仔细看会发现其实是用的。js是动态生成的。这里我们需要了解一下js是如何获取链接的。得到链接后,我们会继续获取下一条新闻的html代码,而且会一次又一次的开始。

期间肯定不会一帆风顺。比如我遇到了301跳转。幸运的是,从请求头中很容易找到跳转目标。找到301跳转后,立即放弃请求,重新请求跳转地址。

另外,爬虫不能无限爬取,否则很容易被IP屏蔽,需要设置爬取次数限制。最好再设置一个爬取间隔,不过这个只是用于学习Nodejs,不会有爬取,所以不需要再设置一个爬取间隔。

详细流程分析见原文地址:%E7%88%AC%E8%99%AB%E5%AE%9E%E8%B7%B5%E5%B0%8F%E8%AE%B0/。

项目源代码:Github。 查看全部

nodejs抓取动态网页(Nodejs将JavaScript语言带到了服务器端(图)网络爬虫)

Nodejs 将 JavaScript 语言带到了服务器端。Nodejs作为js主要用户的前端,已经获得了服务器端的开发能力,但是除了用express搭建博客,还能做哪些好玩的项目呢?你为什么不只是一个网络爬虫。据说互联网上90%以上的流量是由爬虫贡献的。不知道是真是假,但至少证明了爬虫被广泛使用,尤其是在电商比价领域。它做的是爬虫中的弱鸡,只实现基本功能,见底部代码。

运行结果:

下面简要介绍实现过程。

先选择爬取对象,这里也是门槛比较低的新闻站,因为我每天早上都要去逛街,比较熟悉,为什么新闻站比较简单,因为通常是这种类型的网站不需要用户登录,所有爬虫请求都很容易伪造。

爬虫的基本思路是获取页面 -> 构造信息选择器 -> 分析页面链接 -> 获取相邻页面 -> 循环的第一步,对于新闻站来说,我们想要得到什么就是新闻内容,向页面请求html代码后,只要从页面中找到内容容器元素,就很容易得到新闻内容。下一步是获取相邻页面的地址。cnBeta新闻有上一页和下一页的链接,但仔细看会发现其实是用的。js是动态生成的。这里我们需要了解一下js是如何获取链接的。得到链接后,我们会继续获取下一条新闻的html代码,而且会一次又一次的开始。

期间肯定不会一帆风顺。比如我遇到了301跳转。幸运的是,从请求头中很容易找到跳转目标。找到301跳转后,立即放弃请求,重新请求跳转地址。

另外,爬虫不能无限爬取,否则很容易被IP屏蔽,需要设置爬取次数限制。最好再设置一个爬取间隔,不过这个只是用于学习Nodejs,不会有爬取,所以不需要再设置一个爬取间隔。

详细流程分析见原文地址:%E7%88%AC%E8%99%AB%E5%AE%9E%E8%B7%B5%E5%B0%8F%E8%AE%B0/。

项目源代码:Github。

nodejs抓取动态网页(1.在项目文件夹安装两个必须的依赖包npminstallsupe是什么)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-02-16 02:24

在开始之前,请确保您已经安装了 Node.js 环境。如果没有安装,可以到Somei Technology下载安装。

1.在项目文件夹中安装两个需要的依赖

npminstallsupe

在开始之前,请确保您已经安装了 Node.js 环境。如果没有安装,可以到Somei Technology下载安装。

1.在项目文件夹中安装两个需要的依赖

npm install superagent --save-dev

superagent是一个轻量级的渐进式ajax api,可读性好,学习曲线低,内部依赖nodejs原生请求api,适用于nodejs环境

npm install cheerio --save-dev

Cheerio 是一个用于 nodejs 的爬虫页面模块。它是专门为服务器定制的一个快速、灵活且可实现的 jQuery 核心实现。适用于各种网络爬虫程序。等效于 node.js 中的 jQuery

2.新建一个 crawler.js 文件

//导入依赖包

const http = require("http");

const path = require("path");

const url = require("url");

const fs = require("fs");

const superagent = require("superagent");

const cheerio = require("cheerio");

3.获取 Boos 直接就业数据

superagent

.get("https://www.zhipin.com/job_det ... 6quot;)

.end((error,response)=>{

//获取页面文档数据

var content = response.text;

//cheerio也就是nodejs下的jQuery 将整个文档包装成一个集合,定义一个变量$接收

var $ = cheerio.load(content);

//定义一个空数组,用来接收数据

var result=[];

//分析文档结构 先获取每个li 再遍历里面的内容(此时每个li里面就存放着我们想要获取的数据)

$(".job-list li .job-primary").each((index,value)=>{

//地址和类型为一行显示,需要用到字符串截取

//地址

let address=$(value).find(".info-primary").children().eq(1).html();

//类型

let type=$(value).find(".info-company p").html();

//解码

address=unescape(address.replace(/&#x/g,'%u').replace(/;/g,''));

type=unescape(type.replace(/&#x/g,'%u').replace(/;/g,''))

//字符串截取

let addressArr=address.split('');

let typeArr=type.split('');

//将获取的数据以对象的形式添加到数组中

result.push({

title:$(value).find(".name .job-title").text(),

money:$(value).find(".name .red").text(),

address:addressArr,

company:$(value).find(".info-company a").text(),

type:typeArr,

position:$(value).find(".info-publis .name").text(),

txImg:$(value).find(".info-publis img").attr("src"),

time:$(value).find(".info-publis p").text()

});

// console.log(typeof $(value).find(".info-primary").children().eq(1).html());

});

//将数组转换成字符串

result=JSON.stringify(result);

//将数组输出到json文件里 刷新目录 即可看到当前文件夹多出一个boss.json文件(打开boss.json文件,ctrl+A全选之后 ctrl+K,再Ctrl+F即可将json文件自动排版)

fs.writeFile("boss.json",result,"utf-8",(error)=>{

//监听错误,如正常输出,则打印null

if(error==null){

console.log("恭喜您,数据爬取成功!请打开json文件,先Ctrl+A,再Ctrl+K,最后Ctrl+F格式化后查看json文件(仅限Visual Studio Code编辑器)");

}

});

});

总结

以上就是小编介绍的爬虫爬取数据的Nodejs实现。我希望它对你有帮助。有任何问题请给我留言,小编会及时回复你的。还要感谢大家对染美科技的支持网站! 查看全部

nodejs抓取动态网页(1.在项目文件夹安装两个必须的依赖包npminstallsupe是什么)

在开始之前,请确保您已经安装了 Node.js 环境。如果没有安装,可以到Somei Technology下载安装。

1.在项目文件夹中安装两个需要的依赖

npminstallsupe

在开始之前,请确保您已经安装了 Node.js 环境。如果没有安装,可以到Somei Technology下载安装。

1.在项目文件夹中安装两个需要的依赖

npm install superagent --save-dev

superagent是一个轻量级的渐进式ajax api,可读性好,学习曲线低,内部依赖nodejs原生请求api,适用于nodejs环境

npm install cheerio --save-dev

Cheerio 是一个用于 nodejs 的爬虫页面模块。它是专门为服务器定制的一个快速、灵活且可实现的 jQuery 核心实现。适用于各种网络爬虫程序。等效于 node.js 中的 jQuery

2.新建一个 crawler.js 文件

//导入依赖包

const http = require("http");

const path = require("path");

const url = require("url");

const fs = require("fs");

const superagent = require("superagent");

const cheerio = require("cheerio");

3.获取 Boos 直接就业数据

superagent

.get("https://www.zhipin.com/job_det ... 6quot;)

.end((error,response)=>{

//获取页面文档数据

var content = response.text;

//cheerio也就是nodejs下的jQuery 将整个文档包装成一个集合,定义一个变量$接收

var $ = cheerio.load(content);

//定义一个空数组,用来接收数据

var result=[];

//分析文档结构 先获取每个li 再遍历里面的内容(此时每个li里面就存放着我们想要获取的数据)

$(".job-list li .job-primary").each((index,value)=>{

//地址和类型为一行显示,需要用到字符串截取

//地址

let address=$(value).find(".info-primary").children().eq(1).html();

//类型

let type=$(value).find(".info-company p").html();

//解码

address=unescape(address.replace(/&#x/g,'%u').replace(/;/g,''));

type=unescape(type.replace(/&#x/g,'%u').replace(/;/g,''))

//字符串截取

let addressArr=address.split('');

let typeArr=type.split('');

//将获取的数据以对象的形式添加到数组中

result.push({

title:$(value).find(".name .job-title").text(),

money:$(value).find(".name .red").text(),

address:addressArr,

company:$(value).find(".info-company a").text(),

type:typeArr,

position:$(value).find(".info-publis .name").text(),

txImg:$(value).find(".info-publis img").attr("src"),

time:$(value).find(".info-publis p").text()

});

// console.log(typeof $(value).find(".info-primary").children().eq(1).html());

});

//将数组转换成字符串

result=JSON.stringify(result);

//将数组输出到json文件里 刷新目录 即可看到当前文件夹多出一个boss.json文件(打开boss.json文件,ctrl+A全选之后 ctrl+K,再Ctrl+F即可将json文件自动排版)

fs.writeFile("boss.json",result,"utf-8",(error)=>{

//监听错误,如正常输出,则打印null

if(error==null){

console.log("恭喜您,数据爬取成功!请打开json文件,先Ctrl+A,再Ctrl+K,最后Ctrl+F格式化后查看json文件(仅限Visual Studio Code编辑器)");

}

});

});

总结

以上就是小编介绍的爬虫爬取数据的Nodejs实现。我希望它对你有帮助。有任何问题请给我留言,小编会及时回复你的。还要感谢大家对染美科技的支持网站!

nodejs抓取动态网页(网络爬虫(webcrawler)、增量式网络机器人(incremental) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-02-16 02:22

)

前言

?? 网络爬虫(又称网络蜘蛛、网络机器人,在foaf社区,更常称为网页追逐者),是一种按照一定的规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。

?? 我们可以使用网络爬虫来自动采集的数据信息,比如搜索引擎中的站点收录的爬取,对数据采集的数据分析和挖掘,用于财务分析进行采集在金融数据上,此外,网络爬虫还可用于舆情监测分析、目标客户数据采集等各个领域。

1、网络爬虫分类

根据系统结构和实现技术,网络爬虫大致可以分为以下几种:通用网络爬虫、聚焦网络爬虫、增量网络爬虫、深度网络爬虫。实际的网络爬虫系统通常是通过几种爬虫技术的组合来实现的。下面简单介绍一下这几种爬虫。

1.1、万能网络爬虫

又称可伸缩网络爬虫,爬取对象从一些种子URL扩展到整个网络,主要针对门户网站搜索引擎和大型网络服务商采集数据。

1.2、关注网络爬虫

话题爬虫也称为话题爬虫,是指选择性地爬取与预定义话题相关的页面的网络爬虫。与一般的网络爬虫相比,专注爬虫只需要爬取主题相关的页面,大大节省了硬件和网络资源,而且由于页面少,保存的页面更新也很快。信息需求。

1.3、增量网络爬虫

指增量更新下载的网页的爬虫,只爬取新生成或更改的网页。可以在一定程度上保证爬取的页面尽可能的新。.

1.4、深网爬虫

网页按存在方式可分为表层网页(surface web)和深层网页(deep web,也称为隐形网页或隐藏网页)。表面网页是指可以被传统搜索引擎检索到的页面,以及主要由可以通过超链接到达的静态网页组成的网页。深网是那些大部分内容无法通过静态链接访问的网页,隐藏在搜索表单后面,只有在用户提交一些 关键词 时才可用。

2、创建一个简单的爬虫应用

?? 简单了解以上爬虫后,我们来实现一个简单的爬虫应用。

2.1、实现目标

说到爬虫,大概率会想到大数据,然后会想到python。百度之后,python的爬虫确实多了。由于我主要做前端开发,所以相对来说javascript更熟练,也更简单。实现一个小目标,然后用nodejs爬取首页文章列表(自己常用的一个开发者网站),然后写入本地json文件。

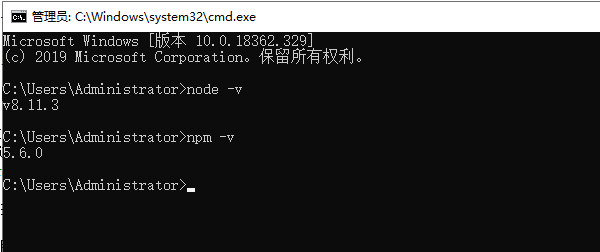

2.2、环境建设

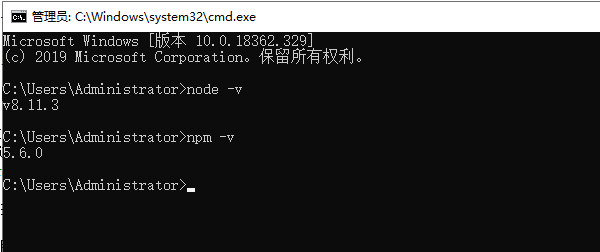

nodejs安装好后,打开命令行,使用node -v查看nodejs是否安装成功,使用npm -v查看nodejs是否安装成功,如果安装成功应该打印如下信息(不同版本不同):

2.3、具体实现

2.3.1、安装依赖

在目录下执行 npm install superagentcheerio --save-dev 安装superagent和cheerio。创建一个 crawler.js 文件。

// 导入依赖包

const http = require("http");

const path = require("path");

const url = require("url");

const fs = require("fs");

const superagent = require("superagent");

const cheerio = require("cheerio");

2.3.2、爬取数据

然后获取请求页面,获取页面内容后,根据你想要的数据解析返回的DOM,最后将处理后的结果json转成字符串保存在本地。

//爬取页面地址

const pageurl="https://www.cnblogs.com/";

// 解码字符串

function unescapestring(str){

if(!str){

return ''

}else{

return unescape(str.replace(/&#x/g,'%u').replace(/;/g,''));

}

}

// 抓取数据

function fetchdata(){

console.log('爬取数据时间节点:',new date());

superagent.get(pageurl).end((error,response)=>{

// 页面文档数据

let content=response.text;

if(content){

console.log('获取数据成功');

}

// 定义一个空数组来接收数据

let result=[];

let $=cheerio.load(content);

let postlist=$("#main #post_list .post_item");

postlist.each((index,value)=>{

let titlelnk=$(value).find('a.titlelnk');

let itemfoot=$(value).find('.post_item_foot');

let title=titlelnk.html(); //标题

let //链接

let author=itemfoot.find('a.lightblue').html(); //作者

let headlogo=$(value).find('.post_item_summary a img').attr('src'); //头像

let summary=$(value).find('.post_item_summary').text(); //简介

let postedtime=itemfoot.text().split('发布于 ')[1].substr(0,16); //发布时间

let readnum=itemfoot.text().split('阅读')[1]; //阅读量

readnum=readnum.substr(1,readnum.length-1);

title=unescapestring(title);

author=unescapestring(author);

headlogo=unescapestring(headlogo);

summary=unescapestring(summary);

postedtime=unescapestring(postedtime);

readnum=unescapestring(readnum);

result.push({

index,

title,

href,

author,

headlogo,

summary,

postedtime,

readnum

});

});

// 数组转换为字符串

result=json.stringify(result);

// 写入本地cnblogs.json文件中

fs.writefile("cnblogs.json",result,"utf-8",(err)=>{

// 监听错误,如正常输出,则打印null

if(!err){

console.log('写入数据成功');

}

});

});

}

fetchdata();

3、执行优化

3.1、生成结果

在项目目录下打开命令行,输入node crawler.js,

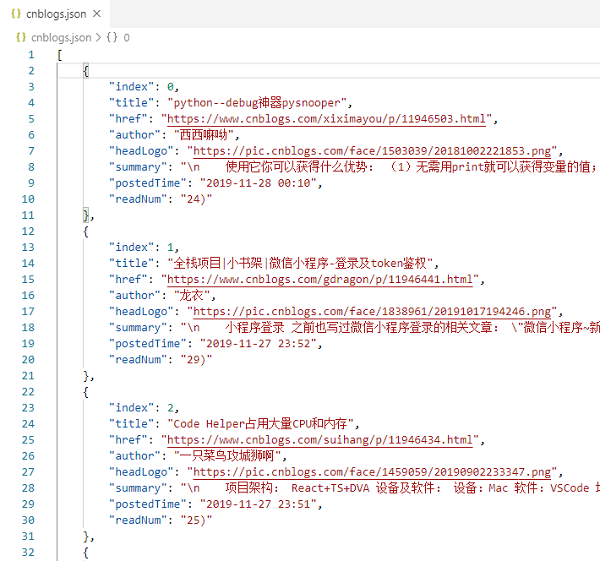

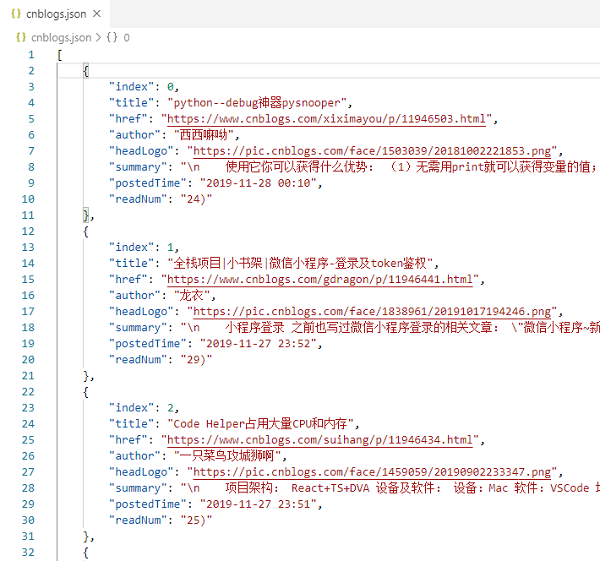

你会发现目录下会创建一个cnblogs.json文件,打开文件如下:

查看全部

nodejs抓取动态网页(网络爬虫(webcrawler)、增量式网络机器人(incremental)

)

前言

?? 网络爬虫(又称网络蜘蛛、网络机器人,在foaf社区,更常称为网页追逐者),是一种按照一定的规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。

?? 我们可以使用网络爬虫来自动采集的数据信息,比如搜索引擎中的站点收录的爬取,对数据采集的数据分析和挖掘,用于财务分析进行采集在金融数据上,此外,网络爬虫还可用于舆情监测分析、目标客户数据采集等各个领域。

1、网络爬虫分类

根据系统结构和实现技术,网络爬虫大致可以分为以下几种:通用网络爬虫、聚焦网络爬虫、增量网络爬虫、深度网络爬虫。实际的网络爬虫系统通常是通过几种爬虫技术的组合来实现的。下面简单介绍一下这几种爬虫。

1.1、万能网络爬虫

又称可伸缩网络爬虫,爬取对象从一些种子URL扩展到整个网络,主要针对门户网站搜索引擎和大型网络服务商采集数据。

1.2、关注网络爬虫

话题爬虫也称为话题爬虫,是指选择性地爬取与预定义话题相关的页面的网络爬虫。与一般的网络爬虫相比,专注爬虫只需要爬取主题相关的页面,大大节省了硬件和网络资源,而且由于页面少,保存的页面更新也很快。信息需求。

1.3、增量网络爬虫

指增量更新下载的网页的爬虫,只爬取新生成或更改的网页。可以在一定程度上保证爬取的页面尽可能的新。.

1.4、深网爬虫

网页按存在方式可分为表层网页(surface web)和深层网页(deep web,也称为隐形网页或隐藏网页)。表面网页是指可以被传统搜索引擎检索到的页面,以及主要由可以通过超链接到达的静态网页组成的网页。深网是那些大部分内容无法通过静态链接访问的网页,隐藏在搜索表单后面,只有在用户提交一些 关键词 时才可用。

2、创建一个简单的爬虫应用

?? 简单了解以上爬虫后,我们来实现一个简单的爬虫应用。

2.1、实现目标

说到爬虫,大概率会想到大数据,然后会想到python。百度之后,python的爬虫确实多了。由于我主要做前端开发,所以相对来说javascript更熟练,也更简单。实现一个小目标,然后用nodejs爬取首页文章列表(自己常用的一个开发者网站),然后写入本地json文件。

2.2、环境建设

nodejs安装好后,打开命令行,使用node -v查看nodejs是否安装成功,使用npm -v查看nodejs是否安装成功,如果安装成功应该打印如下信息(不同版本不同):

2.3、具体实现

2.3.1、安装依赖

在目录下执行 npm install superagentcheerio --save-dev 安装superagent和cheerio。创建一个 crawler.js 文件。

// 导入依赖包

const http = require("http");

const path = require("path");

const url = require("url");

const fs = require("fs");

const superagent = require("superagent");

const cheerio = require("cheerio");

2.3.2、爬取数据

然后获取请求页面,获取页面内容后,根据你想要的数据解析返回的DOM,最后将处理后的结果json转成字符串保存在本地。

//爬取页面地址

const pageurl="https://www.cnblogs.com/";

// 解码字符串

function unescapestring(str){

if(!str){

return ''

}else{

return unescape(str.replace(/&#x/g,'%u').replace(/;/g,''));

}

}

// 抓取数据

function fetchdata(){

console.log('爬取数据时间节点:',new date());

superagent.get(pageurl).end((error,response)=>{

// 页面文档数据

let content=response.text;

if(content){

console.log('获取数据成功');

}

// 定义一个空数组来接收数据

let result=[];

let $=cheerio.load(content);

let postlist=$("#main #post_list .post_item");

postlist.each((index,value)=>{

let titlelnk=$(value).find('a.titlelnk');

let itemfoot=$(value).find('.post_item_foot');

let title=titlelnk.html(); //标题

let //链接

let author=itemfoot.find('a.lightblue').html(); //作者

let headlogo=$(value).find('.post_item_summary a img').attr('src'); //头像

let summary=$(value).find('.post_item_summary').text(); //简介

let postedtime=itemfoot.text().split('发布于 ')[1].substr(0,16); //发布时间

let readnum=itemfoot.text().split('阅读')[1]; //阅读量

readnum=readnum.substr(1,readnum.length-1);

title=unescapestring(title);

author=unescapestring(author);

headlogo=unescapestring(headlogo);

summary=unescapestring(summary);

postedtime=unescapestring(postedtime);

readnum=unescapestring(readnum);

result.push({

index,

title,

href,

author,

headlogo,

summary,

postedtime,

readnum

});

});

// 数组转换为字符串

result=json.stringify(result);

// 写入本地cnblogs.json文件中

fs.writefile("cnblogs.json",result,"utf-8",(err)=>{

// 监听错误,如正常输出,则打印null

if(!err){

console.log('写入数据成功');

}

});

});

}

fetchdata();

3、执行优化

3.1、生成结果

在项目目录下打开命令行,输入node crawler.js,

你会发现目录下会创建一个cnblogs.json文件,打开文件如下:

nodejs抓取动态网页(第二篇自动爬虫入门(二)爬取动态页面(puppeteer))

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-02-14 15:14

上次写第二篇爬虫教程Node.js爬虫介绍(二)爬取动态页面(puppeteer)讲解使用puppeteer打开无头浏览器进行动态数据爬取,这是一年前的事了,现在的原因这么久没更新是因为开始学爬虫的目的是为了搭建一个自动爬虫系统,去年我开发了陌陌热榜,实现之后就停止研究爬虫了。

陌陌热榜的开发涉及到很多功能模块,包括界面设计和前端开发,后端高度自定义爬虫功能和登录模块,数据表设计,自动化部署等,学到了很多,这次我将使用自动爬虫我们来谈谈这个功能。这次我们来说说定时爬取功能的实现:

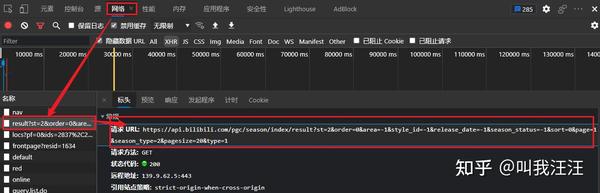

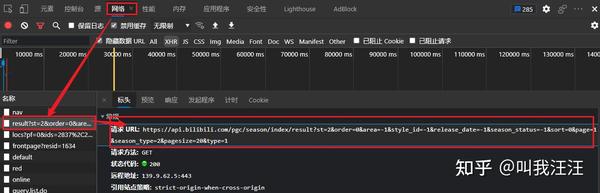

先打开你要爬取的网站看看是动态网页还是静态网页。重点就在这里。如果是静态网页,则很容易处理。使用cheerio进行dom爬取请参考第一讲。; 如果是ajax动态加载的话,除了第二讲,其实还有另一种方式,用F12打开开发者工具,找到网络请求,找到你要爬取的请求地址。

以百度热榜为例,我每分钟抓取一次百度热榜的标题数据,拼接标题和搜索量,打印出来。它是一个动态加载的网页。按照上面的方法,找到请求地址为/mobile_v2/buzz/hotspot,然后尝试爬取:

const request = require('request')

request('http://top.baidu.com/mobile_v2 ... 39%3B, (err, res) => {

if (err) {

console.log(err.code)

return false;

}

let data = JSON.parse(res.body).result.topwords

console.log(`${data[0].keyword} - ${data[0].searches}次搜索`)

})

// 运行结果 -> 湖北十堰爆炸致11死 省长赶往现场 - 4974558次搜索

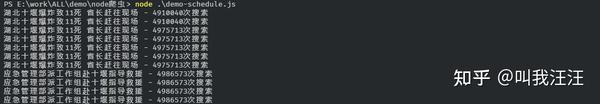

爬行没有问题。实现定时爬取,使用调度库实现简单的定时任务。使用 schedule.scheduleJob() 方法启动计划任务。第一个参数是定时器,即你想多久执行一次;第二个参数是执行函数。

定时器建议使用 Cron 样式,如:'* * *' 6 个占位符代表秒、分、小时、天、月、星期几,星号代表完全匹配。- 在每分钟的第 30 秒触发:'30 * *' - 在每小时的 1 分 30 秒触发:'30 1 * *' - 在每天凌晨 1:1:30 触发:'30 1 1* ' - 每天 每月 1 日 1:1:30 触发:'30 1 1 1*' - 2016 年 1 月 1 日 1:1:30 触发:'30 1 1 1 2016' - 1 点 1:1每周的分 30 秒触发:'30 1 1 * 1'

现在想每分钟抓取一次百度热搜头条的数据,那么

const schedule = require('node-schedule')

const request = require('request')

schedule.scheduleJob('0 * * * * *', () => {

request('http://top.baidu.com/mobile_v2 ... 39%3B, (err, res) => {

if (err) {

console.log(err.code)

return false;

}

let data = JSON.parse(res.body).result.topwords

console.log(`${data[0].keyword} - ${data[0].searches}次搜索`)

})

})

运行结果是:

做吧~ 查看全部

nodejs抓取动态网页(第二篇自动爬虫入门(二)爬取动态页面(puppeteer))

上次写第二篇爬虫教程Node.js爬虫介绍(二)爬取动态页面(puppeteer)讲解使用puppeteer打开无头浏览器进行动态数据爬取,这是一年前的事了,现在的原因这么久没更新是因为开始学爬虫的目的是为了搭建一个自动爬虫系统,去年我开发了陌陌热榜,实现之后就停止研究爬虫了。

陌陌热榜的开发涉及到很多功能模块,包括界面设计和前端开发,后端高度自定义爬虫功能和登录模块,数据表设计,自动化部署等,学到了很多,这次我将使用自动爬虫我们来谈谈这个功能。这次我们来说说定时爬取功能的实现:

先打开你要爬取的网站看看是动态网页还是静态网页。重点就在这里。如果是静态网页,则很容易处理。使用cheerio进行dom爬取请参考第一讲。; 如果是ajax动态加载的话,除了第二讲,其实还有另一种方式,用F12打开开发者工具,找到网络请求,找到你要爬取的请求地址。

以百度热榜为例,我每分钟抓取一次百度热榜的标题数据,拼接标题和搜索量,打印出来。它是一个动态加载的网页。按照上面的方法,找到请求地址为/mobile_v2/buzz/hotspot,然后尝试爬取:

const request = require('request')

request('http://top.baidu.com/mobile_v2 ... 39%3B, (err, res) => {

if (err) {

console.log(err.code)

return false;

}

let data = JSON.parse(res.body).result.topwords

console.log(`${data[0].keyword} - ${data[0].searches}次搜索`)

})

// 运行结果 -> 湖北十堰爆炸致11死 省长赶往现场 - 4974558次搜索

爬行没有问题。实现定时爬取,使用调度库实现简单的定时任务。使用 schedule.scheduleJob() 方法启动计划任务。第一个参数是定时器,即你想多久执行一次;第二个参数是执行函数。

定时器建议使用 Cron 样式,如:'* * *' 6 个占位符代表秒、分、小时、天、月、星期几,星号代表完全匹配。- 在每分钟的第 30 秒触发:'30 * *' - 在每小时的 1 分 30 秒触发:'30 1 * *' - 在每天凌晨 1:1:30 触发:'30 1 1* ' - 每天 每月 1 日 1:1:30 触发:'30 1 1 1*' - 2016 年 1 月 1 日 1:1:30 触发:'30 1 1 1 2016' - 1 点 1:1每周的分 30 秒触发:'30 1 1 * 1'

现在想每分钟抓取一次百度热搜头条的数据,那么

const schedule = require('node-schedule')

const request = require('request')

schedule.scheduleJob('0 * * * * *', () => {

request('http://top.baidu.com/mobile_v2 ... 39%3B, (err, res) => {

if (err) {

console.log(err.code)

return false;

}

let data = JSON.parse(res.body).result.topwords

console.log(`${data[0].keyword} - ${data[0].searches}次搜索`)

})

})

运行结果是:

做吧~

nodejs抓取动态网页(/module/cvsresovle/js)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-02-13 18:13

有这样一个需求,先从cvs文件中读取要解析的url数据,然后使用puppeteer和puppeteer-har获取浏览器的HAR数据。在调试的过程中发现for循环中怎么操作是异步的,终于找到了解决办法,这里也记录一下。

1、创建解析csv文件的代码(ultra-harlog/module/cvsresovle.js)

const fs = require("fs");

const path = require("path");

const csv =require('csv');

const parse = require('csv-parse/lib/sync')

const iconv = require('iconv-lite');

/*

npm install iconv-lite

*/

function readUrlRecord(csvpath){

console.log('开始解析文件:' + csvpath) ;

//读取文件

const input = fs.readFileSync(csvpath,'utf8') ;

/*

解析文件,生成JSON格式

{ ' ': '142',

AREA_NAME: '湖北',

SITE_LINK: 'www.banggo.com',

BEARING_MODE: '移动接入',

SITE_NAME: '邦购',

MENU_TYPE: '二级' }

*/

const records = parse(input, {

columns: true,

skip_empty_lines: true,

delimiter: ',',

}) ;

return records ;

}

//readUrlRecord('../top300.csv') ;

exports.readUrlRecord = readUrlRecord;

2、创建抓取的主代码(ultra-harlog/module/puppeteerhar-event.js)

const fs = require('fs');

const { promisify } = require('util');

const path = require("path");

const puppeteer = require('puppeteer');

const { harFromMessages } = require('chrome-har');

const logger=require("./log");

const log = logger.getPuppeteerHarEventRecordLogger() ;

//https://michaljanaszek.com/blo ... eteer

//https://www.npmjs.com/package/chrome-har

// 设置要监控的事件

const observe = [

'Page.loadEventFired',

'Page.domContentEventFired',

'Page.frameStartedLoading',

'Page.frameAttached',

'Network.requestWillBeSent',

'Network.requestServedFromCache',

'Network.dataReceived',

'Network.responseReceived',

'Network.resourceChangedPriority',

'Network.loadingFinished',

'Network.loadingFailed',

];

/*

启动浏览器

*/

async function launchBrowser(){

//启动浏览器实例 [puppeteer.createBrowserFetcher([options])]

let browser = await puppeteer.launch({

// 若是手动下载的chromium需要指定chromium地址, 默认引用地址为 /项目目录/node_modules/puppeteer/.local-chromium/

//executablePath: '/Users/huqiyang/Documents/project/z/chromium/Chromium.app/Contents/MacOS/Chromium',

//如果是访问https页面 此属性会忽略https错误

ignoreHTTPSErrors: true,

// 关闭headless模式, 不会打开浏览器

headless: true,

//浏览器启动参数 https://peter.sh/experiments/c ... ches/ --timeout

args:["--disk-cache-size=0","--disable-cache",'--disable-infobars','--window-size=800,600','--ignore-certificate-errors','--enable-feaures'],

//是否为每个选项卡自动打开DevTools面板。 如果此选项为true,则headless选项将设置为false。

devtools: false,

//Defaults to 30000 (30 seconds). Pass 0 to disable timeout.

timeout: 0

//放慢puppeteer执行的动作,方便调试

//slowMo: 250

});

return browser ;

}

async function saveHarlog(url,dirPath,filename){

let homesite = url ;

//保存的文件路径

let harFilePath = path.join(dirPath,filename) ;

//处理URL

if(!(url.startsWith('http://') || url.startsWith('https://'))){

url = "http://" + url ;

}

//打开浏览器

let browser = await launchBrowser() ;

//创建一个新页面

//let page = await browser.newPage();

let page = (await browser.pages())[0];

// 注册事件监听器

const client = await page.target().createCDPSession();

await client.send('Page.enable');

await client.send('Network.enable');

//用于保存用于转为为HAR数据的事件

const events = [];

observe.forEach(method => {

client.on(method, params => {

events.push({ method, params });

});

});

try{

// 执行跳转,访问制定的资源

await page.goto(url,{

timeout:0

});

}catch(error){

log.info('resovle error :' + url + "; error message:" + error) ;

}finally{

if(browser){

await browser.close();

}

}

const har = harFromMessages(events);

//resovleHar(har) ;

//log.info(JSON.stringify(har));

await promisify(fs.writeFile)(harFilePath, JSON.stringify(har));

}

exports.launchBrowser = launchBrowser;

exports.saveHarlog = saveHarlog;

3、创建启动文件(ultra-harlog/puppeteerhar-event-app.js) 查看全部

nodejs抓取动态网页(/module/cvsresovle/js)

有这样一个需求,先从cvs文件中读取要解析的url数据,然后使用puppeteer和puppeteer-har获取浏览器的HAR数据。在调试的过程中发现for循环中怎么操作是异步的,终于找到了解决办法,这里也记录一下。

1、创建解析csv文件的代码(ultra-harlog/module/cvsresovle.js)

const fs = require("fs");

const path = require("path");

const csv =require('csv');

const parse = require('csv-parse/lib/sync')

const iconv = require('iconv-lite');

/*

npm install iconv-lite

*/

function readUrlRecord(csvpath){

console.log('开始解析文件:' + csvpath) ;

//读取文件

const input = fs.readFileSync(csvpath,'utf8') ;

/*

解析文件,生成JSON格式

{ ' ': '142',

AREA_NAME: '湖北',

SITE_LINK: 'www.banggo.com',

BEARING_MODE: '移动接入',

SITE_NAME: '邦购',

MENU_TYPE: '二级' }

*/

const records = parse(input, {

columns: true,

skip_empty_lines: true,

delimiter: ',',

}) ;

return records ;

}

//readUrlRecord('../top300.csv') ;

exports.readUrlRecord = readUrlRecord;

2、创建抓取的主代码(ultra-harlog/module/puppeteerhar-event.js)

const fs = require('fs');

const { promisify } = require('util');

const path = require("path");

const puppeteer = require('puppeteer');

const { harFromMessages } = require('chrome-har');

const logger=require("./log");

const log = logger.getPuppeteerHarEventRecordLogger() ;

//https://michaljanaszek.com/blo ... eteer

//https://www.npmjs.com/package/chrome-har

// 设置要监控的事件

const observe = [

'Page.loadEventFired',

'Page.domContentEventFired',

'Page.frameStartedLoading',

'Page.frameAttached',

'Network.requestWillBeSent',

'Network.requestServedFromCache',

'Network.dataReceived',

'Network.responseReceived',

'Network.resourceChangedPriority',

'Network.loadingFinished',

'Network.loadingFailed',

];

/*

启动浏览器

*/

async function launchBrowser(){

//启动浏览器实例 [puppeteer.createBrowserFetcher([options])]

let browser = await puppeteer.launch({

// 若是手动下载的chromium需要指定chromium地址, 默认引用地址为 /项目目录/node_modules/puppeteer/.local-chromium/

//executablePath: '/Users/huqiyang/Documents/project/z/chromium/Chromium.app/Contents/MacOS/Chromium',

//如果是访问https页面 此属性会忽略https错误

ignoreHTTPSErrors: true,

// 关闭headless模式, 不会打开浏览器

headless: true,

//浏览器启动参数 https://peter.sh/experiments/c ... ches/ --timeout

args:["--disk-cache-size=0","--disable-cache",'--disable-infobars','--window-size=800,600','--ignore-certificate-errors','--enable-feaures'],

//是否为每个选项卡自动打开DevTools面板。 如果此选项为true,则headless选项将设置为false。

devtools: false,

//Defaults to 30000 (30 seconds). Pass 0 to disable timeout.

timeout: 0

//放慢puppeteer执行的动作,方便调试

//slowMo: 250

});

return browser ;

}

async function saveHarlog(url,dirPath,filename){

let homesite = url ;

//保存的文件路径

let harFilePath = path.join(dirPath,filename) ;

//处理URL

if(!(url.startsWith('http://') || url.startsWith('https://'))){

url = "http://" + url ;

}

//打开浏览器

let browser = await launchBrowser() ;

//创建一个新页面

//let page = await browser.newPage();

let page = (await browser.pages())[0];

// 注册事件监听器

const client = await page.target().createCDPSession();

await client.send('Page.enable');

await client.send('Network.enable');

//用于保存用于转为为HAR数据的事件

const events = [];

observe.forEach(method => {

client.on(method, params => {

events.push({ method, params });

});

});

try{

// 执行跳转,访问制定的资源

await page.goto(url,{

timeout:0

});

}catch(error){

log.info('resovle error :' + url + "; error message:" + error) ;

}finally{

if(browser){

await browser.close();

}

}

const har = harFromMessages(events);

//resovleHar(har) ;

//log.info(JSON.stringify(har));

await promisify(fs.writeFile)(harFilePath, JSON.stringify(har));

}

exports.launchBrowser = launchBrowser;

exports.saveHarlog = saveHarlog;

3、创建启动文件(ultra-harlog/puppeteerhar-event-app.js)

nodejs抓取动态网页(【技术创作101训练营】用NodeJS来入门image.png第二页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-02-13 03:10

【科技创造101训练营】使用NodeJS上手爬虫

image.png 演讲第一页:大家好,今天主要给大家分享使用NodeJS上手爬虫 image.png 演讲第二页:现在简单介绍一下我讲的一些内容今天,首先,什么是爬行动物?还有为什么会有爬虫,然后怎么做爬虫,最后是扩展和总结 image.png 演讲第三页:什么是爬虫,嗯,我们写了一个爬虫程序,然后会是这样的一个爬虫,然后就会在网上层出不穷,自动模仿人,image.png第四页演讲:那为什么要有爬虫呢,嗯,比如说搜索引擎可以用爬虫爬一些关键词,一些内容,然后方便我们搜索;那么它也可以聚合信息,比如一些内容< @网站,比如头条等,可以利用爬虫整合其他平台的信息并下载HTML源代码,然后去获取数据;还有一种情况,当我们发现HTML源代码中没有想要的数据时,他可能通过接口请求,通过JS渲染,这样我们就可以通过抓包查看它的接口,然后通过界面。接口获取想要的数据嗯,这两个库主要是使用真实的浏览器访问页面,等待页面请求数据并渲染,然后使用选择器获取DOM获取指定数据 image.png 讲座第10页手稿:接下来我们可以看个例子,然后他主要爬取掘金列表的文章的标题 他们可以使用爬虫整合其他平台的信息并下载HTML源代码,然后去获取数据;还有一种情况,当我们发现HTML源码中没有想要的数据时,他可能通过接口请求,通过JS渲染,这样我们就可以通过抓包查看它的接口,然后通过界面。接口获取想要的数据嗯,这两个库主要是使用真实的浏览器访问页面,等待页面请求数据并渲染,然后使用选择器获取DOM获取指定数据 image.png 讲座第10页手稿:接下来我们可以看个例子,然后他主要爬取掘金列表的文章的标题 他们可以使用爬虫整合其他平台的信息并下载HTML源代码,然后去获取数据;还有一种情况,当我们发现HTML源码中没有想要的数据时,他可能通过接口请求,通过JS渲染,这样我们就可以通过抓包查看它的接口,然后通过界面。接口获取想要的数据嗯,这两个库主要是使用真实的浏览器访问页面,等待页面请求数据并渲染,然后使用选择器获取DOM获取指定数据 image.png 讲座第10页手稿:接下来我们可以看个例子,然后他主要爬取掘金列表的文章的标题 还有一种情况,当我们发现HTML源码中没有想要的数据时,他可能通过接口请求,通过JS渲染,这样我们就可以通过抓包查看它的接口,然后通过界面。接口获取想要的数据嗯,这两个库主要是使用真实浏览器访问页面,等待页面请求数据并渲染,然后使用选择器获取DOM获取指定数据 image.png Lecture第10页手稿:接下来我们可以看个例子,然后他主要爬取掘金列表的文章的标题 还有一种情况,当我们发现HTML源码中没有想要的数据时,他可能通过接口请求,通过JS渲染,这样我们就可以通过抓包查看它的接口,然后通过界面。接口获取想要的数据嗯,这两个库主要是使用真实的浏览器访问页面,等待页面请求数据并渲染,然后使用选择器获取DOM获取指定数据 image.png 讲座第10页手稿:接下来我们可以看个例子,然后他主要爬取掘金列表的文章的标题

346 查看全部

nodejs抓取动态网页(【技术创作101训练营】用NodeJS来入门image.png第二页)

【科技创造101训练营】使用NodeJS上手爬虫

image.png 演讲第一页:大家好,今天主要给大家分享使用NodeJS上手爬虫 image.png 演讲第二页:现在简单介绍一下我讲的一些内容今天,首先,什么是爬行动物?还有为什么会有爬虫,然后怎么做爬虫,最后是扩展和总结 image.png 演讲第三页:什么是爬虫,嗯,我们写了一个爬虫程序,然后会是这样的一个爬虫,然后就会在网上层出不穷,自动模仿人,image.png第四页演讲:那为什么要有爬虫呢,嗯,比如说搜索引擎可以用爬虫爬一些关键词,一些内容,然后方便我们搜索;那么它也可以聚合信息,比如一些内容< @网站,比如头条等,可以利用爬虫整合其他平台的信息并下载HTML源代码,然后去获取数据;还有一种情况,当我们发现HTML源代码中没有想要的数据时,他可能通过接口请求,通过JS渲染,这样我们就可以通过抓包查看它的接口,然后通过界面。接口获取想要的数据嗯,这两个库主要是使用真实的浏览器访问页面,等待页面请求数据并渲染,然后使用选择器获取DOM获取指定数据 image.png 讲座第10页手稿:接下来我们可以看个例子,然后他主要爬取掘金列表的文章的标题 他们可以使用爬虫整合其他平台的信息并下载HTML源代码,然后去获取数据;还有一种情况,当我们发现HTML源码中没有想要的数据时,他可能通过接口请求,通过JS渲染,这样我们就可以通过抓包查看它的接口,然后通过界面。接口获取想要的数据嗯,这两个库主要是使用真实的浏览器访问页面,等待页面请求数据并渲染,然后使用选择器获取DOM获取指定数据 image.png 讲座第10页手稿:接下来我们可以看个例子,然后他主要爬取掘金列表的文章的标题 他们可以使用爬虫整合其他平台的信息并下载HTML源代码,然后去获取数据;还有一种情况,当我们发现HTML源码中没有想要的数据时,他可能通过接口请求,通过JS渲染,这样我们就可以通过抓包查看它的接口,然后通过界面。接口获取想要的数据嗯,这两个库主要是使用真实的浏览器访问页面,等待页面请求数据并渲染,然后使用选择器获取DOM获取指定数据 image.png 讲座第10页手稿:接下来我们可以看个例子,然后他主要爬取掘金列表的文章的标题 还有一种情况,当我们发现HTML源码中没有想要的数据时,他可能通过接口请求,通过JS渲染,这样我们就可以通过抓包查看它的接口,然后通过界面。接口获取想要的数据嗯,这两个库主要是使用真实浏览器访问页面,等待页面请求数据并渲染,然后使用选择器获取DOM获取指定数据 image.png Lecture第10页手稿:接下来我们可以看个例子,然后他主要爬取掘金列表的文章的标题 还有一种情况,当我们发现HTML源码中没有想要的数据时,他可能通过接口请求,通过JS渲染,这样我们就可以通过抓包查看它的接口,然后通过界面。接口获取想要的数据嗯,这两个库主要是使用真实的浏览器访问页面,等待页面请求数据并渲染,然后使用选择器获取DOM获取指定数据 image.png 讲座第10页手稿:接下来我们可以看个例子,然后他主要爬取掘金列表的文章的标题

346

nodejs抓取动态网页(前端渲染和后端渲染的优势是怎样的??)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2022-02-11 08:06

同构渲染是指在前后端使用js。第一次渲染时,使用 nodejs 来加载我们的 HTML 文件。用小白的话来说,同构渲染既不是后端渲染,也不是前端渲染,是两者之间的共同部分。同构渲染的实现其实是SSR+CSH,都是通过代码实现的。

这里说的是前端渲染和后端渲染,各有各的优势。前端渲染的优点包括:可以部分刷新,可以实现懒加载技术,可以用js实现各种炫酷效果,可以通过cdn服务器访问资源,前后端开发都可以分离,学习成本相对较低。后端的主要优点是:可以解决首屏加载问题,有利于seo的优化。

随着技术的发展,像Vue、React这样的框架已经能够实现很好的同构渲染,也就是我们常说的SSR,比如nuxt.js和next.js。在前端渲染非常普遍的今天,为什么还要有同构渲染的技术呢?

如前所述,同构渲染其实可以解决首屏加载慢和SEO优化的问题。

传统的搜索引擎从 HTML 文件中爬取我们需要的数据,所以前端渲染的页面无法爬取。开发过vue和react项目的开发者都知道,我们经常使用的SPA会将所有JS打包成一个整体。一个不容忽视的问题是文件太大,导致渲染前的等待时间过长。尤其是网速不好的时候,等待白屏结束对用户来说体验不是很好。

服务端渲染可以先将使用过的数据渲染成最终的HTML直接展示,理想的避免了白屏问题。但没有什么是绝对的。如果一个页面的数据量太大,难免会出现等待的情况。

说到PHP和JSP的渲染方式,都是前端将页面写到后端后渲染出来的HTML页面。其实pass中的SSR原理是一样的,只是多了一层CSH。其实现需要服务器提供初始化数据。 查看全部

nodejs抓取动态网页(前端渲染和后端渲染的优势是怎样的??)

同构渲染是指在前后端使用js。第一次渲染时,使用 nodejs 来加载我们的 HTML 文件。用小白的话来说,同构渲染既不是后端渲染,也不是前端渲染,是两者之间的共同部分。同构渲染的实现其实是SSR+CSH,都是通过代码实现的。

这里说的是前端渲染和后端渲染,各有各的优势。前端渲染的优点包括:可以部分刷新,可以实现懒加载技术,可以用js实现各种炫酷效果,可以通过cdn服务器访问资源,前后端开发都可以分离,学习成本相对较低。后端的主要优点是:可以解决首屏加载问题,有利于seo的优化。

随着技术的发展,像Vue、React这样的框架已经能够实现很好的同构渲染,也就是我们常说的SSR,比如nuxt.js和next.js。在前端渲染非常普遍的今天,为什么还要有同构渲染的技术呢?

如前所述,同构渲染其实可以解决首屏加载慢和SEO优化的问题。

传统的搜索引擎从 HTML 文件中爬取我们需要的数据,所以前端渲染的页面无法爬取。开发过vue和react项目的开发者都知道,我们经常使用的SPA会将所有JS打包成一个整体。一个不容忽视的问题是文件太大,导致渲染前的等待时间过长。尤其是网速不好的时候,等待白屏结束对用户来说体验不是很好。

服务端渲染可以先将使用过的数据渲染成最终的HTML直接展示,理想的避免了白屏问题。但没有什么是绝对的。如果一个页面的数据量太大,难免会出现等待的情况。

说到PHP和JSP的渲染方式,都是前端将页面写到后端后渲染出来的HTML页面。其实pass中的SSR原理是一样的,只是多了一层CSH。其实现需要服务器提供初始化数据。

nodejs抓取动态网页(ES6ES6模块的只读代码和javascript的区别?模块)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-02-10 10:12

安装node,百度查,node -v查询版本

node.js 和 javascript 之间的区别

es

定义了语法,js和nodejs都要遵守

不能操作dom,不能监听click,不能发送ajax

js

使用es语法,外加webAPI,可以操作dom,事件绑定,ajax等

nodejs

使用es语法,外加nodejsAPI,处理htpp,处理文件等

commonjs 模块化,node.js 使用了这种模块化

一个.js

function add(a, b) {

return a + b

}

function mul(a, b) {

return a * b

}

module.exports = {

add,

mul

}

b.js

const { add, mul } = require('./a')

const _ = require('lodash')

const sum = add(10, 20)

const result = mul(100, 200)

console.log(sum)

console.log(result)

const arr = _.concat([1, 2], 3)

console.log('arr...', arr)

npm init 初始化,运行,节点 b.js

CommonJS 模块和 ES6 模块 CommonJS 的区别在于基本数据类型的复制。将被模块缓存。同时,该模块输出的变量可以在另一个模块中重新赋值。对于复杂的数据类型,它是一个浅拷贝。由于两个模块引用的对象都指向同一个内存空间,所以改变这个模块的值会影响到另一个模块。当使用 require 命令加载模块时,会运行整个模块的代码。当使用 require 命令加载同一个模块时,该模块不会被执行,而是会检索缓存中的值。也就是说,CommonJS 模块无论加载多少次,第一次加载时只会运行一次。如果稍后加载,它将返回第一次运行的结果,除非手动清除系统缓存。当循环被加载时,它属于加载时执行。也就是当需要脚本代码的时候,都会全部执行。一旦一个模块被“循环加载”,只会输出执行的部分,不会输出未执行的部分。ES6 Modules ES6 模块中的值属于[Dynamic Read-Only References]。对于只读,即不允许修改导入变量的值。导入的变量是只读的,无论是基本数据类型还是复杂数据类型。当模块遇到导入命令时,会生成一个只读引用。当脚本实际执行时,根据这个只读引用,去加载的模块获取值。对于动态,原创值发生变化,导入加载的值也发生变化。无论是基本数据类型还是复杂数据类型。ES6 模块在循环加载时被动态引用。只要两个模块之间有一些引用,代码就可以执行。

默认导出 export default 变量或者函数或者对象

默认引入 import name from "相对或绝对路径"

导出的名字和引入的名字可以不一致

按需导出 export 需要声明 变量用const var let 函数用function

按需引入 import {变量名或函数名} form "路径"

全部引入 使用 import * as 自定义name "路径"

会将默认导出和按需导出 全部引入

服务器开发和前端开发的区别

1.服务稳定,服务端可能遭受恶意攻击

2.日志记录,单个客户端可以意外挂掉,但是服务端不行,pm2正在等待进程

3.内存优化,服务器端承载很多请求,CPU和内存都是稀缺资源,用stream写日志,用redis存储session

4.安全,服务器端可能会受到恶意攻击,未经授权的操作,数据库攻击,防止xss攻击,spl注入

5.集群和服务拆分,扩大服务和机器拆分流量

6.日志记录,服务器要记录日志,存储日志,分析日志。 查看全部

nodejs抓取动态网页(ES6ES6模块的只读代码和javascript的区别?模块)

安装node,百度查,node -v查询版本

node.js 和 javascript 之间的区别

es

定义了语法,js和nodejs都要遵守

不能操作dom,不能监听click,不能发送ajax

js

使用es语法,外加webAPI,可以操作dom,事件绑定,ajax等

nodejs

使用es语法,外加nodejsAPI,处理htpp,处理文件等

commonjs 模块化,node.js 使用了这种模块化

一个.js

function add(a, b) {

return a + b

}

function mul(a, b) {

return a * b

}

module.exports = {

add,

mul

}

b.js

const { add, mul } = require('./a')

const _ = require('lodash')

const sum = add(10, 20)

const result = mul(100, 200)

console.log(sum)

console.log(result)

const arr = _.concat([1, 2], 3)

console.log('arr...', arr)

npm init 初始化,运行,节点 b.js

CommonJS 模块和 ES6 模块 CommonJS 的区别在于基本数据类型的复制。将被模块缓存。同时,该模块输出的变量可以在另一个模块中重新赋值。对于复杂的数据类型,它是一个浅拷贝。由于两个模块引用的对象都指向同一个内存空间,所以改变这个模块的值会影响到另一个模块。当使用 require 命令加载模块时,会运行整个模块的代码。当使用 require 命令加载同一个模块时,该模块不会被执行,而是会检索缓存中的值。也就是说,CommonJS 模块无论加载多少次,第一次加载时只会运行一次。如果稍后加载,它将返回第一次运行的结果,除非手动清除系统缓存。当循环被加载时,它属于加载时执行。也就是当需要脚本代码的时候,都会全部执行。一旦一个模块被“循环加载”,只会输出执行的部分,不会输出未执行的部分。ES6 Modules ES6 模块中的值属于[Dynamic Read-Only References]。对于只读,即不允许修改导入变量的值。导入的变量是只读的,无论是基本数据类型还是复杂数据类型。当模块遇到导入命令时,会生成一个只读引用。当脚本实际执行时,根据这个只读引用,去加载的模块获取值。对于动态,原创值发生变化,导入加载的值也发生变化。无论是基本数据类型还是复杂数据类型。ES6 模块在循环加载时被动态引用。只要两个模块之间有一些引用,代码就可以执行。

默认导出 export default 变量或者函数或者对象

默认引入 import name from "相对或绝对路径"

导出的名字和引入的名字可以不一致

按需导出 export 需要声明 变量用const var let 函数用function

按需引入 import {变量名或函数名} form "路径"

全部引入 使用 import * as 自定义name "路径"

会将默认导出和按需导出 全部引入

服务器开发和前端开发的区别

1.服务稳定,服务端可能遭受恶意攻击

2.日志记录,单个客户端可以意外挂掉,但是服务端不行,pm2正在等待进程

3.内存优化,服务器端承载很多请求,CPU和内存都是稀缺资源,用stream写日志,用redis存储session

4.安全,服务器端可能会受到恶意攻击,未经授权的操作,数据库攻击,防止xss攻击,spl注入

5.集群和服务拆分,扩大服务和机器拆分流量

6.日志记录,服务器要记录日志,存储日志,分析日志。

nodejs抓取动态网页( ()函数的处理方法与对应的修改 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-02-07 22:15

()函数的处理方法与对应的修改

)

<p>现存在如下图所示的文件目录: <br /> <br /> 我们希望通过02.js来实现能够静态加载static中的文件 <br /> 这篇博客是我的上一篇博客静态资源管理续篇,在上一篇博客中,因为遇到加载json格式的文件遇到了问题,所以写了一个续篇,如果有感兴趣的小伙伴可以看一下 <br /> 实现代码如下:

var http = require('http');

var url = require('url');

var fs = require('fs');

var path = require('path');

var server = http.createServer(function (req,res) {

//这里如果不用req.url来判断,那么不管用户输入什么操作,执行的操作都是一样的

//得到地址

var pathname = url.parse(req.url).pathname;

//不处理小图标的请求

if(pathname == '/favicon.ico'){

return;

}

//判断此时用户输入的是文件地址还是文件夹地址

//如果是文件夹地址,那么自动请求这个文件夹中的index.html

if(pathname.indexOf('.') == -1){

pathname += 'index.html';

}

//得到用户输入的文件的拓展名

var extname = path.extname(pathname);

console.log(pathname);

fs.readFile('./static/'+pathname,function (err,data) {

if(err){

//如果页面报错,则让它返回一个新的页面

fs.readFile('./static/404.html',function (err,data) {

res.writeHead(200,{'Content-Type':'text/html;charset=UTF8'});

res.end(data);

})

return;

}

//读完文件之后做的事情

console.log(process.cwd());

var mime = getMime(extname);

res.writeHead(200,{'Content-Type':mime+';charset=UTF8'});

res.end(data);

})

}).listen(80,'127.0.0.1');

function getMime(extname) {

//读取mime.josn文件,得到JOSN,根据extname key ,f返回对应的value值

switch (extname){

case '.html':

return 'text/html';

break;

case '.css':

return 'text/css';

break;

case '.img':

return 'image/img';

break;

case '.json':

fs.readFile('./static/mime.json',function (err,data) {

if(err){

throw Error("找不到mime.json文件!");

return;

}

//转成JSON

console.log(typeof data);

//利用json.parse将一个josn字符串解析成为json格式

var mimeJSON = JSON.parse(data);

console.log(mimeJSON[extname]);

return mimeJSON[extname];

})

}

}</p>

当我们读取到文件的扩展名是json时,我们读取的是json格式的文件,然后使用JSON.parse()方法将JSON字符串转换为JSON对象,然后检索JSON对象。转成json扩展名对应的MIME类型。

然而,我们惊讶地发现响应头中的 content-type 类型是未定义的,

但是我们不是已经在这部分代码中写好文件类型了吗?

这是因为getMime()函数,当传入参数为'.json'时,函数执行代码中收录异步操作,即读取json文件,所以在未读取文件时,mime有还没读完。赋值时mime已写入content-type,未定义;

那我们该怎么办呢?

我们采取强制回调函数getMime的方法,传入文件的扩展名后,再执行回调函数中的内容,并将mime的值赋值给content-type,避免出现问题异步加载。

修改代码如下:

getMime(extname,function(mime){

res.writeHead(200,{'Content-Type':mime+';charset=UTF8'});

res.end(data);

})

这样,我们就可以在参数mime的值返回后,进行将type值赋给Content-type的操作。对应的getMime()函数也应该相应修改:

function getMime(extname,callback){

//读取mime的json文件,将对应扩展名的MIME类型名返回

fs.readfile('./static/mime.json',function(err,data){

if(err){

throw Error('找不到mime.json类型的文件!');

}

//将json字符串转换为json对象

var mimeJSON = JSON.parse(data);

var mime = mimeJSON[extname] || 'text/plain

';

callback(mime);

})

} 查看全部

nodejs抓取动态网页(

()函数的处理方法与对应的修改

)

<p>现存在如下图所示的文件目录: <br />

<br /> 我们希望通过02.js来实现能够静态加载static中的文件 <br /> 这篇博客是我的上一篇博客静态资源管理续篇,在上一篇博客中,因为遇到加载json格式的文件遇到了问题,所以写了一个续篇,如果有感兴趣的小伙伴可以看一下 <br /> 实现代码如下:

<br /> 我们希望通过02.js来实现能够静态加载static中的文件 <br /> 这篇博客是我的上一篇博客静态资源管理续篇,在上一篇博客中,因为遇到加载json格式的文件遇到了问题,所以写了一个续篇,如果有感兴趣的小伙伴可以看一下 <br /> 实现代码如下: var http = require('http');

var url = require('url');

var fs = require('fs');

var path = require('path');

var server = http.createServer(function (req,res) {

//这里如果不用req.url来判断,那么不管用户输入什么操作,执行的操作都是一样的

//得到地址

var pathname = url.parse(req.url).pathname;

//不处理小图标的请求

if(pathname == '/favicon.ico'){

return;

}

//判断此时用户输入的是文件地址还是文件夹地址

//如果是文件夹地址,那么自动请求这个文件夹中的index.html

if(pathname.indexOf('.') == -1){

pathname += 'index.html';

}

//得到用户输入的文件的拓展名

var extname = path.extname(pathname);

console.log(pathname);

fs.readFile('./static/'+pathname,function (err,data) {

if(err){

//如果页面报错,则让它返回一个新的页面

fs.readFile('./static/404.html',function (err,data) {

res.writeHead(200,{'Content-Type':'text/html;charset=UTF8'});

res.end(data);

})

return;

}

//读完文件之后做的事情

console.log(process.cwd());

var mime = getMime(extname);

res.writeHead(200,{'Content-Type':mime+';charset=UTF8'});

res.end(data);

})

}).listen(80,'127.0.0.1');

function getMime(extname) {

//读取mime.josn文件,得到JOSN,根据extname key ,f返回对应的value值

switch (extname){

case '.html':

return 'text/html';

break;

case '.css':

return 'text/css';

break;

case '.img':

return 'image/img';

break;

case '.json':

fs.readFile('./static/mime.json',function (err,data) {

if(err){

throw Error("找不到mime.json文件!");

return;

}

//转成JSON

console.log(typeof data);

//利用json.parse将一个josn字符串解析成为json格式

var mimeJSON = JSON.parse(data);

console.log(mimeJSON[extname]);

return mimeJSON[extname];

})

}

}</p>

当我们读取到文件的扩展名是json时,我们读取的是json格式的文件,然后使用JSON.parse()方法将JSON字符串转换为JSON对象,然后检索JSON对象。转成json扩展名对应的MIME类型。

然而,我们惊讶地发现响应头中的 content-type 类型是未定义的,

但是我们不是已经在这部分代码中写好文件类型了吗?

这是因为getMime()函数,当传入参数为'.json'时,函数执行代码中收录异步操作,即读取json文件,所以在未读取文件时,mime有还没读完。赋值时mime已写入content-type,未定义;

那我们该怎么办呢?

我们采取强制回调函数getMime的方法,传入文件的扩展名后,再执行回调函数中的内容,并将mime的值赋值给content-type,避免出现问题异步加载。

修改代码如下:

getMime(extname,function(mime){

res.writeHead(200,{'Content-Type':mime+';charset=UTF8'});

res.end(data);

})

这样,我们就可以在参数mime的值返回后,进行将type值赋给Content-type的操作。对应的getMime()函数也应该相应修改:

function getMime(extname,callback){

//读取mime的json文件,将对应扩展名的MIME类型名返回

fs.readfile('./static/mime.json',function(err,data){

if(err){

throw Error('找不到mime.json类型的文件!');

}

//将json字符串转换为json对象

var mimeJSON = JSON.parse(data);

var mime = mimeJSON[extname] || 'text/plain

';

callback(mime);

})

}

nodejs抓取动态网页(puppeteer和nodejs的区别)

网站优化 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-02-06 15:03

傀儡师

google chrome 团队出品的 puppeteer 是一个依赖 nodejs 和 chromium 的自动化测试库。它最大的优点是可以处理网页中的动态内容,比如JavaScript,可以更好地模拟用户。

一些网站的反爬方法隐藏了一些javascript/ajax请求中的部分内容,使得直接获取a标签的方法不起作用。甚至一些 网站 会设置隐藏元素“陷阱”,对用户不可见,脚本将其作为机器触发。在这种情况下,puppeteer的优势就凸显出来了。

它可以实现以下功能:

生成页面的屏幕截图和 PDF。抓取 SPA 并生成预渲染内容(即“xxxx”)。自动提交表单、UI测试、键盘输入等。创建最新的自动化测试环境。使用最新的 JavaScript 和浏览器功能直接在最新版本的 Chrome 中运行测试。捕获跟踪您的 网站 的时间线以帮助诊断性能问题。

开源地址:[][1]

安装

npm i puppeteer

注意先安装nodejs,在nodejs文件的根目录下执行(与npm文件同级)。

安装过程中会下载chromium,大约120M。

经过两天(大约10个小时)的探索,绕过了很多异步的坑,作者对puppeteer和nodejs有一定的把握。

长图,抢博客文章列表:

爬博客文章

以csdn博客为例,文章的内容需要通过点击“阅读全文”获取,使得只能阅读dom的脚本失效。

/**

* load blog.csdn.net article to local files

**/

const puppeteer = require('puppeteer');

//emulate iphone

const userAgent = 'Mozilla/5.0 (iPhone; CPU iPhone OS 11_0 like Mac OS X) AppleWebKit/604.1.38 (KHTML, like Gecko) Version/11.0 Mobile/15A372 Safari/604.1';

const workPath = './contents';

const fs = require("fs");

if (!fs.existsSync(workPath)) {

fs.mkdirSync(workPath)

}

//base url

const rootUrl = 'https://blog.csdn.net/';

//max wait milliseconds

const maxWait = 100;

//max loop scroll times

const makLoop = 10;

(async () => {

let url;

let countUrl=0;

const browser = await puppeteer.launch({headless: false});//set headless: true will hide chromium UI

const page = await browser.newPage();

await page.setUserAgent(userAgent);

await page.setViewport({width:414, height:736});

await page.setRequestInterception(true);

//filter to block images

page.on('request', request => {

if (request.resourceType() === 'image')

request.abort();

else

request.continue();

});

await page.goto(rootUrl);

for(let i= 0; iwindow.scrollTo(0, document.body.scrollHeight));

await page.waitForNavigation({timeout:maxWait,waitUntil: ['networkidle0']});

}catch(err){

console.log('scroll to bottom and then wait '+maxWait+'ms.');

}

}

await page.screenshot({path: workPath+'/screenshot.png',fullPage: true, quality :100, type :'jpeg'});

//#feedlist_id li[data-type="blog"] a

const sel = '#feedlist_id li[data-type="blog"] h2 a';

const hrefs = await page.evaluate((sel) => {

let elements = Array.from(document.querySelectorAll(sel));

let links = elements.map(element => {

return element.href

})

return links;

}, sel);

console.log('total links: '+hrefs.length);

process();

async function process(){

if(countUrl {

if (request.resourceType() === 'image')

request.abort();

else

request.continue();

});

await tab.goto(url);

//execute tap request

try{

await tab.tap('.read_more_btn');

}catch(err){

console.log('there\'s none read more button. No need to TAP');

}

let title = await tab.evaluate(() => document.querySelector('#article .article_title').innerText);

let contents = await tab.evaluate(() => document.querySelector('#article .article_content').innerText);

contents = 'TITLE: '+title+'\nURL: '+url+'\nCONTENTS: \n'+contents;

const fs = require("fs");

fs.writeFileSync(workPath+'/'+tab.url().substring(tab.url().lastIndexOf('/'),tab.url().length)+'.txt',contents);

console.log(title + " has been downloaded to local.");

await tab.close();

}catch(err){

console.log('url: '+tab.url()+' \n'+err.toString());

}finally{

process();

}

}

})();

实施过程

录屏可以在我的公众号查看,截图如下:

结果

文章内容列表:

文章内容:

结束语

之前我想既然nodejs使用的是JavaScript脚本语言,那么它一定能够处理网页的JavaScript内容,但是我还没有找到一个合适/高效的库。直到我找到了 puppeteer,我才决定试水。

说了这么多,nodejs的异步性真是让人头疼。这几百行代码我折腾了10个小时。

您可以在代码中展开 process() 方法并使用 async.eachSeries。我使用的递归方法不是最佳解决方案。

事实上,一个一个地处理是没有效率的。本来我写了一个异步关闭浏览器的方法:

<p>let tryCloseBrowser = setInterval(function(){

console.log("check if any process running...")

if(countDown 查看全部

nodejs抓取动态网页(puppeteer和nodejs的区别)

傀儡师

google chrome 团队出品的 puppeteer 是一个依赖 nodejs 和 chromium 的自动化测试库。它最大的优点是可以处理网页中的动态内容,比如JavaScript,可以更好地模拟用户。

一些网站的反爬方法隐藏了一些javascript/ajax请求中的部分内容,使得直接获取a标签的方法不起作用。甚至一些 网站 会设置隐藏元素“陷阱”,对用户不可见,脚本将其作为机器触发。在这种情况下,puppeteer的优势就凸显出来了。

它可以实现以下功能:

生成页面的屏幕截图和 PDF。抓取 SPA 并生成预渲染内容(即“xxxx”)。自动提交表单、UI测试、键盘输入等。创建最新的自动化测试环境。使用最新的 JavaScript 和浏览器功能直接在最新版本的 Chrome 中运行测试。捕获跟踪您的 网站 的时间线以帮助诊断性能问题。

开源地址:[][1]

安装

npm i puppeteer

注意先安装nodejs,在nodejs文件的根目录下执行(与npm文件同级)。

安装过程中会下载chromium,大约120M。

经过两天(大约10个小时)的探索,绕过了很多异步的坑,作者对puppeteer和nodejs有一定的把握。

长图,抢博客文章列表:

爬博客文章

以csdn博客为例,文章的内容需要通过点击“阅读全文”获取,使得只能阅读dom的脚本失效。

/**

* load blog.csdn.net article to local files

**/

const puppeteer = require('puppeteer');

//emulate iphone

const userAgent = 'Mozilla/5.0 (iPhone; CPU iPhone OS 11_0 like Mac OS X) AppleWebKit/604.1.38 (KHTML, like Gecko) Version/11.0 Mobile/15A372 Safari/604.1';

const workPath = './contents';

const fs = require("fs");

if (!fs.existsSync(workPath)) {

fs.mkdirSync(workPath)

}

//base url

const rootUrl = 'https://blog.csdn.net/';

//max wait milliseconds

const maxWait = 100;

//max loop scroll times

const makLoop = 10;

(async () => {

let url;

let countUrl=0;

const browser = await puppeteer.launch({headless: false});//set headless: true will hide chromium UI

const page = await browser.newPage();

await page.setUserAgent(userAgent);

await page.setViewport({width:414, height:736});

await page.setRequestInterception(true);

//filter to block images

page.on('request', request => {

if (request.resourceType() === 'image')

request.abort();

else

request.continue();

});

await page.goto(rootUrl);

for(let i= 0; iwindow.scrollTo(0, document.body.scrollHeight));

await page.waitForNavigation({timeout:maxWait,waitUntil: ['networkidle0']});

}catch(err){

console.log('scroll to bottom and then wait '+maxWait+'ms.');

}

}

await page.screenshot({path: workPath+'/screenshot.png',fullPage: true, quality :100, type :'jpeg'});

//#feedlist_id li[data-type="blog"] a

const sel = '#feedlist_id li[data-type="blog"] h2 a';

const hrefs = await page.evaluate((sel) => {

let elements = Array.from(document.querySelectorAll(sel));

let links = elements.map(element => {

return element.href

})

return links;

}, sel);

console.log('total links: '+hrefs.length);

process();

async function process(){

if(countUrl {

if (request.resourceType() === 'image')

request.abort();

else

request.continue();

});

await tab.goto(url);

//execute tap request

try{

await tab.tap('.read_more_btn');

}catch(err){

console.log('there\'s none read more button. No need to TAP');

}

let title = await tab.evaluate(() => document.querySelector('#article .article_title').innerText);

let contents = await tab.evaluate(() => document.querySelector('#article .article_content').innerText);

contents = 'TITLE: '+title+'\nURL: '+url+'\nCONTENTS: \n'+contents;

const fs = require("fs");

fs.writeFileSync(workPath+'/'+tab.url().substring(tab.url().lastIndexOf('/'),tab.url().length)+'.txt',contents);

console.log(title + " has been downloaded to local.");

await tab.close();

}catch(err){

console.log('url: '+tab.url()+' \n'+err.toString());

}finally{

process();

}

}

})();

实施过程

录屏可以在我的公众号查看,截图如下:

结果

文章内容列表:

文章内容:

结束语

之前我想既然nodejs使用的是JavaScript脚本语言,那么它一定能够处理网页的JavaScript内容,但是我还没有找到一个合适/高效的库。直到我找到了 puppeteer,我才决定试水。

说了这么多,nodejs的异步性真是让人头疼。这几百行代码我折腾了10个小时。

您可以在代码中展开 process() 方法并使用 async.eachSeries。我使用的递归方法不是最佳解决方案。

事实上,一个一个地处理是没有效率的。本来我写了一个异步关闭浏览器的方法:

<p>let tryCloseBrowser = setInterval(function(){

console.log("check if any process running...")

if(countDown

nodejs抓取动态网页(我目前正在使用Express.js创建我的网站。。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-02-06 05:28

我目前正在使用 Express.js 来创建我的 网站。我的主服务器脚本称为 index.coffee。我还创建了一个脚本 request.js,它发出一个 GET 请求并显示响应

console.log(list);

我从控制台运行脚本没有任何问题:node request.js

我的问题是:如何让页面上的“获取此列表”按钮通过在同一页面上显示列表来响应点击(即request.js在服务器上执行并显示结果)?

app.js

/**

* Module dependencies.

*/

var express = require('express')

, routes = require('./routes');

var app = module.exports = express.createServer();

// Configuration

app.configure(function(){

app.set('views', __dirname + '/views');

app.set ('view engine', 'coffee');

app.register('.coffee', require('coffeekup').adapters.express);

app.use(express.bodyParser());

app.use(express.methodOverride());

app.use(app.router);

app.use(express.static(__dirname + '/public'));

});

app.configure('development', function(){

app.use(express.errorHandler({ dumpExceptions: true, showStack: true }));

});

app.configure('production', function(){

app.use(express.errorHandler());

});

app.get('/', function(req, res) {

res.render('index',{ layout: false });

});

app.listen(3000);

console.log("Express server listening on port %d in %s mode", app.address().port, app.settings.env);

索引咖啡

doctype 5

html ->

head ->

body

p->“嘿” 查看全部

nodejs抓取动态网页(我目前正在使用Express.js创建我的网站。。)

我目前正在使用 Express.js 来创建我的 网站。我的主服务器脚本称为 index.coffee。我还创建了一个脚本 request.js,它发出一个 GET 请求并显示响应

console.log(list);

我从控制台运行脚本没有任何问题:node request.js

我的问题是:如何让页面上的“获取此列表”按钮通过在同一页面上显示列表来响应点击(即request.js在服务器上执行并显示结果)?

app.js

/**

* Module dependencies.

*/

var express = require('express')

, routes = require('./routes');

var app = module.exports = express.createServer();

// Configuration

app.configure(function(){

app.set('views', __dirname + '/views');

app.set ('view engine', 'coffee');

app.register('.coffee', require('coffeekup').adapters.express);

app.use(express.bodyParser());

app.use(express.methodOverride());

app.use(app.router);

app.use(express.static(__dirname + '/public'));

});

app.configure('development', function(){

app.use(express.errorHandler({ dumpExceptions: true, showStack: true }));

});

app.configure('production', function(){

app.use(express.errorHandler());

});

app.get('/', function(req, res) {

res.render('index',{ layout: false });

});

app.listen(3000);

console.log("Express server listening on port %d in %s mode", app.address().port, app.settings.env);

索引咖啡

doctype 5

html ->

head ->

body

p->“嘿”

nodejs抓取动态网页( 如何在NodeJS的活跃生态系统帮助下高效地抓取Web内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 532 次浏览 • 2022-02-06 01:15

如何在NodeJS的活跃生态系统帮助下高效地抓取Web内容)

作者 | Shenesh Perera 翻译 | 王强策划| 李俊辰 Javascript 多年来发展迅速,引入了一个叫做 NodeJS 的运行时,因此它已经成为最流行和使用最广泛的语言之一。无论您是在编写 Web 应用程序还是移动应用程序,您都可以在 Javascript 生态系统中找到合适的工具。本文是关于如何借助 NodeJS 的活跃生态系统有效地抓取 Web 内容,以满足大多数相关需求。

本文首发于网站,经网站授权由InfoQ中文站翻译分享。

前提

本文章主要针对有一定Javascript开发经验的开发者。但是,如果您熟悉 Web 内容抓取,那么您可以从本文中学到很多东西,而无需任何 Javascript 经验。

成就

阅读此 文章 可以帮助读者:

了解 NodeJS:简介

Javascript 是一种简单而现代的语言,最初是为了向 网站 浏览器访问添加动态行为而创建的。网站加载后,Javascript 通过浏览器的 JS 引擎运行并翻译成一堆计算机可以理解的代码。为了让 Javascript 与您的浏览器交互,后者提供了一个运行时环境(文档、窗口等)。

换句话说,Javascript 编程语言不能直接与计算机或它们的资源交互,或操纵它们。例如,在 Web 服务器中,服务器必须能够与文件系统交互才能读取文件或将记录存储在数据库中。

NodeJS 的想法是让 Javascript 不仅可以在客户端运行,还可以在服务器端运行。为此,资深开发人员 Ryan Dahl 将 Google Chrome 的 v8 JS 引擎嵌入到名为 Node.js 的 C++ 程序中。所以 NodeJS 是一个运行时环境,它允许用 Javascript 编写的应用程序也可以在服务器上运行。

大多数语言(例如 C 或 C++)使用多个线程来处理并发,相比之下 NodeJS 只使用单个主线程,并借助 Event Loop 以非阻塞的方式使用它来执行任务。我们可以轻松地设置一个简单的 Web 服务器,如下所示:

1const http = require('http');

2const PORT = 3000;

3const server = http.createServer((req, res) => {

4 res.statusCode = 200;

5 res.setHeader('Content-Type', 'text/plain');

6 res.end('Hello World');

7});

8server.listen(port, () => {

9 console.log(`Server running at PORT:${port}/`);

10});

11

如果您安装了 NodeJS,请运行 node.js(删除符号),然后打开浏览器并导航到 localhost:3000 以查看文本“HelloWorld”。NodeJS 非常适合 I/O 密集型应用程序。HTTP 客户端:查询 Web

HTTP 客户端是一种向服务器发送请求,然后从服务器接收响应的工具。本文中讨论的大多数工具在后台使用 HTTP 客户端来查询您将尝试抓取的 网站 服务器。

RequestRequest 是 Javascript 生态系统中使用最广泛的 HTTP 客户端之一,但是现在 Request 库的作者已经正式表示不建议大家继续使用它。不是说不能用,还有很多库还在用,真的很好用。使用 Request 发出 HTTP 请求非常简单:

1const request = require('request')

2request('https://www.reddit.com/r/progr ... 27%3B, function (

3 error,

4 response,

5 body) {

6 console.error('error:', error)

7 console.log('body:', body)

8})

9

你可以在 Github 上找到 Request 库并运行 npm install request 来安装它。在这里您可以参考弃用通知和详细信息:

AxiosAxios 是一个基于 Promise 的 HTTP 客户端,在浏览器和 NodeJS 中运行。如果你使用 Typescript,axios 可以覆盖内置类型。通过axios发起HTTP请求非常简单。默认情况下它具有内置的 Promise 支持,不像 Request,它必须使用回调:

1const axios = require('axios')

2axios

3 .get('https://www.reddit.com/r/programming.json')

4 .then((response) => {

5 console.log(response)

6 })

7 .catch((error) => {

8 console.error(error)

9 });

10

1如果你喜欢 Promises API 的 async/await 语法糖,那么也可以用它们,但由于顶级的 await 仍处于第 3 阶段,我们只能用 Async Function 来代替:

2

1async function getForum() {

2 try {

3 const response = await axios.get(

4 'https://www.reddit.com/r/progr ... 27%3B

5 )

6 console.log(response)

7 } catch (error) {

8 console.error(error)

9 }

10}

11

你只需调用getForum!你可以在 Github 上找到 Axios 库并运行 npm install axios 来安装它。

超级代理

与 Axios 类似,Superagent 是另一个强大的 HTTP 客户端,支持 Promises 和 async/await 语法糖。它的 API 和 Axios 一样简单,但 Superagent 依赖较多,不太流行。

在 Superagent 中,HTTP 请求是使用 Promise、async/await 或回调发出的,如下所示:

1const superagent = require("superagent")

2const forumURL = "https://www.reddit.com/r/programming.json"

3// callbacks

4superagent

5 .get(forumURL)

6 .end((error, response) => {

7 console.log(response)

8 })

9// promises

10superagent

11 .get(forumURL)

12 .then((response) => {

13 console.log(response)

14 })

15 .catch((error) => {

16 console.error(error)

17 })

18// promises with async/await

19async function getForum() {

20 try {

21 const response = await superagent.get(forumURL)

22 console.log(response)

23 } catch (error) {

24 console.error(error)

25 }

26

你可以在 Github 上找到 Superagent 库并运行 npm install superagent 来安装它。

对于下面介绍的网页抓取工具,本文将使用 Axios 作为 HTTP 客户端。正则表达式:艰难之路

在没有任何依赖关系的情况下开始抓取 Web 内容的最简单方法是在使用 HTTP 客户端查询网页时收到的 HTML 字符串上应用一组正则表达式 - 但这种方法绕路太远了。正则表达式不是那么灵活,许多专业人士和爱好者很难编写正确的正则表达式。

对于复杂的网页抓取任务,正则表达式很快就会成为瓶颈。无论如何,让我们先尝试一下。假设有一个带有用户名的标签,我们需要用户名在其中,那么使用正则表达式时的方法几乎是这样的:

1const htmlString = 'Username: John Doe'

2const result = htmlString.match(/(.+)/)

3console.log(result[1], result[1].split(": ")[1])

4// Username: John Doe, John Doe

5

在 Javascript 中,match() 通常返回一个收录与正则表达式匹配的所有内容的数组。第二个元素(在索引 1 处)将找到标签的 textContent 或 innerHTML,这正是我们想要的。但是这个结果将收录一些我们不需要的文本(“用户名:”),必须将其删除。如您所见,这种方法对于一个非常简单的用例来说很麻烦。所以我们应该使用 HTML 解析器之类的工具,这些工具将在后面讨论。Cheerio:在其核心遍历 DOM JQuery Cheerio 是一个高效且轻量级的库,允许您在服务器端使用 JQuery 丰富而强大的 API。如果您以前使用过 JQuery,那么使用 Cheerio 很容易上手。它消除了 DOM 的所有不一致和与浏览器相关的特性,并公开了一个用于解析和操作 DOM 的高效 API。

1const cheerio = require('cheerio')

2const $ = cheerio.load('

3

你好世界

')

$('h2.title').text('你好!')

$('h2').addClass('欢迎')

$.html()

//

你好呀!

如您所见,Cheerio 的工作方式与 JQuery 非常相似。但是,它与 Web 浏览器的工作方式不同,这意味着它不能:

因此,如果您尝试抓取的 网站 或 Web 应用程序有很多 Javascript 内容(例如“单页应用程序”),那么 Cheerio 不是您的最佳选择,您可能不得不依赖以下讨论一些其他选项。

为了展示 Cheerio 的强大功能,我们将尝试爬取 Reddit 中的 r/programming 论坛以获取帖子标题列表。

首先,运行以下命令安装 Cheerio 和 axios:npm install Cheerio axios。然后创建一个名为 crawler.js 的新文件并复制/粘贴以下代码:

1const axios = require('axios');

2const cheerio = require('cheerio');

3const getPostTitles = async () => {

4 try {

5 const { data } = await axios.get(

6 'https://old.reddit.com/r/programming/'

7 );

8 const $ = cheerio.load(data);

9 const postTitles = [];

10 $('div > p.title > a').each((_idx, el) => {

11 const postTitle = $(el).text()

12 postTitles.push(postTitle)

13 });

14 return postTitles;

15 } catch (error) {

16 throw error;

17 }

18};

19getPostTitles()

20.then((postTitles) => console.log(postTitles));

21

getPostTitles() 是一个异步函数,用于抓取旧 reddit 的 r/programming 论坛。首先,使用来自 axios HTTP 客户端库的简单 HTTP GET 请求获取 网站 的 HTML,然后使用cheerio.load() 函数将 html 数据提供给 Cheerio。

接下来,使用浏览器的开发工具,您可以获得通常可以针对所有明信片的选择器。如果您使用过 JQuery,那么 $('div > p.title > a') 非常熟悉。这将获取所有帖子,因为您只想获取每个帖子的标题,您必须遍历每个帖子(使用 each() 函数进行迭代)。

要从每个标题中提取文本,必须在 Cheerio 的帮助下获取 DOM 元素(当前元素的 el)。然后在每个元素上调用 text() 以获取文本。

现在,您可以弹出一个终端并运行 node crawler.js,您会看到一长串大约 25 或 26 个帖子标题。虽然这是一个非常简单的用例,但它显示了 Cheerio 提供的 API 是多么容易使用。

如果您的用例需要执行 Javascript 和加载外部资源,这里有几个选项可供考虑。JSDOM:节点的 DOM

JSDOM 是 NodeJS 中使用的文档对象模型 (DOM) 的纯 Javascript 实现。如前所述,DOM 不适用于 Node,而 JSDOM 是最接近的替代品。它或多或少地模拟了浏览器的机制。

一旦创建了 DOM,我们就可以通过编程方式与要抓取的 Web 应用程序或 网站 进行交互,还可以完成单击按钮之类的操作。如果您熟悉 DOM 的工作原理,那么 JSDOM 也非常易于使用。

1const { JSDOM } = require('jsdom')

2const { document } = new JSDOM(

3 '

4

你好世界

'

)。窗户

constheading = document.querySelector('.title')

heading.textContent = '你好!'

heading.classList.add('欢迎')

标题.innerHTML

//

你好呀!

如您所见,JSDOM 创建了一个 DOM,然后您可以使用与浏览器 DOM 相同的方法和属性对其进行操作。为了演示如何使用 JSDOM 与 网站 交互,我们将在 Redditr/programming 论坛上发表第一篇文章,点赞它,然后我们将验证该帖子是否已被点赞。首先运行以下命令安装jsdom和axios:

1npm install jsdom axios

2

1然后创建一个名为 rawler.js 的文件,并复制 / 粘贴以下代码:

2

1const { JSDOM } = require("jsdom")

2const axios = require('axios')

3const upvoteFirstPost = async () => {

4 try {

5 const { data } = await axios.get("https://old.reddit.com/r/programming/");

6 const dom = new JSDOM(data, {

7 runScripts: "dangerously",

8 resources: "usable"

9 });

10 const { document } = dom.window;

11 const firstPost = document.querySelector("div > div.midcol > div.arrow");

12 firstPost.click();

13 const isUpvoted = firstPost.classList.contains("upmod");

14 const msg = isUpvoted

15 ? "Post has been upvoted successfully!"

16 : "The post has not been upvoted!";

17 return msg;

18 } catch (error) {

19 throw error;

20 }

21};

22upvoteFirstPost().then(msg => console.log(msg));

23

upvoteFirstPost() 是一个异步函数,它将获得 r/programming 中的第一个帖子并对其进行投票。为此,axios 发送一个 HTTP GET 请求以获取指定 URL 的 HTML。然后将先前获取的 HTML 馈送到 JSDOM 以创建新的 DOM。JSDOM 构造函数将 HTML 作为第一个参数,将选项作为第二个参数。添加的 2 个选项执行以下功能: 查看全部

nodejs抓取动态网页(

如何在NodeJS的活跃生态系统帮助下高效地抓取Web内容)

作者 | Shenesh Perera 翻译 | 王强策划| 李俊辰 Javascript 多年来发展迅速,引入了一个叫做 NodeJS 的运行时,因此它已经成为最流行和使用最广泛的语言之一。无论您是在编写 Web 应用程序还是移动应用程序,您都可以在 Javascript 生态系统中找到合适的工具。本文是关于如何借助 NodeJS 的活跃生态系统有效地抓取 Web 内容,以满足大多数相关需求。

本文首发于网站,经网站授权由InfoQ中文站翻译分享。

前提

本文章主要针对有一定Javascript开发经验的开发者。但是,如果您熟悉 Web 内容抓取,那么您可以从本文中学到很多东西,而无需任何 Javascript 经验。

成就

阅读此 文章 可以帮助读者:

了解 NodeJS:简介

Javascript 是一种简单而现代的语言,最初是为了向 网站 浏览器访问添加动态行为而创建的。网站加载后,Javascript 通过浏览器的 JS 引擎运行并翻译成一堆计算机可以理解的代码。为了让 Javascript 与您的浏览器交互,后者提供了一个运行时环境(文档、窗口等)。

换句话说,Javascript 编程语言不能直接与计算机或它们的资源交互,或操纵它们。例如,在 Web 服务器中,服务器必须能够与文件系统交互才能读取文件或将记录存储在数据库中。

NodeJS 的想法是让 Javascript 不仅可以在客户端运行,还可以在服务器端运行。为此,资深开发人员 Ryan Dahl 将 Google Chrome 的 v8 JS 引擎嵌入到名为 Node.js 的 C++ 程序中。所以 NodeJS 是一个运行时环境,它允许用 Javascript 编写的应用程序也可以在服务器上运行。

大多数语言(例如 C 或 C++)使用多个线程来处理并发,相比之下 NodeJS 只使用单个主线程,并借助 Event Loop 以非阻塞的方式使用它来执行任务。我们可以轻松地设置一个简单的 Web 服务器,如下所示:

1const http = require('http');

2const PORT = 3000;

3const server = http.createServer((req, res) => {

4 res.statusCode = 200;

5 res.setHeader('Content-Type', 'text/plain');

6 res.end('Hello World');

7});

8server.listen(port, () => {

9 console.log(`Server running at PORT:${port}/`);

10});

11

如果您安装了 NodeJS,请运行 node.js(删除符号),然后打开浏览器并导航到 localhost:3000 以查看文本“HelloWorld”。NodeJS 非常适合 I/O 密集型应用程序。HTTP 客户端:查询 Web

HTTP 客户端是一种向服务器发送请求,然后从服务器接收响应的工具。本文中讨论的大多数工具在后台使用 HTTP 客户端来查询您将尝试抓取的 网站 服务器。

RequestRequest 是 Javascript 生态系统中使用最广泛的 HTTP 客户端之一,但是现在 Request 库的作者已经正式表示不建议大家继续使用它。不是说不能用,还有很多库还在用,真的很好用。使用 Request 发出 HTTP 请求非常简单:

1const request = require('request')

2request('https://www.reddit.com/r/progr ... 27%3B, function (

3 error,

4 response,

5 body) {

6 console.error('error:', error)

7 console.log('body:', body)

8})

9

你可以在 Github 上找到 Request 库并运行 npm install request 来安装它。在这里您可以参考弃用通知和详细信息:

AxiosAxios 是一个基于 Promise 的 HTTP 客户端,在浏览器和 NodeJS 中运行。如果你使用 Typescript,axios 可以覆盖内置类型。通过axios发起HTTP请求非常简单。默认情况下它具有内置的 Promise 支持,不像 Request,它必须使用回调:

1const axios = require('axios')

2axios

3 .get('https://www.reddit.com/r/programming.json')

4 .then((response) => {

5 console.log(response)

6 })

7 .catch((error) => {

8 console.error(error)

9 });

10

1如果你喜欢 Promises API 的 async/await 语法糖,那么也可以用它们,但由于顶级的 await 仍处于第 3 阶段,我们只能用 Async Function 来代替:

2

1async function getForum() {

2 try {

3 const response = await axios.get(

4 'https://www.reddit.com/r/progr ... 27%3B

5 )

6 console.log(response)

7 } catch (error) {

8 console.error(error)

9 }

10}

11

你只需调用getForum!你可以在 Github 上找到 Axios 库并运行 npm install axios 来安装它。

超级代理

与 Axios 类似,Superagent 是另一个强大的 HTTP 客户端,支持 Promises 和 async/await 语法糖。它的 API 和 Axios 一样简单,但 Superagent 依赖较多,不太流行。

在 Superagent 中,HTTP 请求是使用 Promise、async/await 或回调发出的,如下所示:

1const superagent = require("superagent")

2const forumURL = "https://www.reddit.com/r/programming.json"

3// callbacks

4superagent

5 .get(forumURL)

6 .end((error, response) => {

7 console.log(response)

8 })

9// promises

10superagent

11 .get(forumURL)

12 .then((response) => {

13 console.log(response)

14 })

15 .catch((error) => {

16 console.error(error)

17 })

18// promises with async/await

19async function getForum() {

20 try {

21 const response = await superagent.get(forumURL)

22 console.log(response)

23 } catch (error) {

24 console.error(error)

25 }

26

你可以在 Github 上找到 Superagent 库并运行 npm install superagent 来安装它。

对于下面介绍的网页抓取工具,本文将使用 Axios 作为 HTTP 客户端。正则表达式:艰难之路

在没有任何依赖关系的情况下开始抓取 Web 内容的最简单方法是在使用 HTTP 客户端查询网页时收到的 HTML 字符串上应用一组正则表达式 - 但这种方法绕路太远了。正则表达式不是那么灵活,许多专业人士和爱好者很难编写正确的正则表达式。

对于复杂的网页抓取任务,正则表达式很快就会成为瓶颈。无论如何,让我们先尝试一下。假设有一个带有用户名的标签,我们需要用户名在其中,那么使用正则表达式时的方法几乎是这样的:

1const htmlString = 'Username: John Doe'

2const result = htmlString.match(/(.+)/)

3console.log(result[1], result[1].split(": ")[1])

4// Username: John Doe, John Doe

5

在 Javascript 中,match() 通常返回一个收录与正则表达式匹配的所有内容的数组。第二个元素(在索引 1 处)将找到标签的 textContent 或 innerHTML,这正是我们想要的。但是这个结果将收录一些我们不需要的文本(“用户名:”),必须将其删除。如您所见,这种方法对于一个非常简单的用例来说很麻烦。所以我们应该使用 HTML 解析器之类的工具,这些工具将在后面讨论。Cheerio:在其核心遍历 DOM JQuery Cheerio 是一个高效且轻量级的库,允许您在服务器端使用 JQuery 丰富而强大的 API。如果您以前使用过 JQuery,那么使用 Cheerio 很容易上手。它消除了 DOM 的所有不一致和与浏览器相关的特性,并公开了一个用于解析和操作 DOM 的高效 API。

1const cheerio = require('cheerio')

2const $ = cheerio.load('

3

你好世界

')

$('h2.title').text('你好!')

$('h2').addClass('欢迎')

$.html()

//

你好呀!

如您所见,Cheerio 的工作方式与 JQuery 非常相似。但是,它与 Web 浏览器的工作方式不同,这意味着它不能:

因此,如果您尝试抓取的 网站 或 Web 应用程序有很多 Javascript 内容(例如“单页应用程序”),那么 Cheerio 不是您的最佳选择,您可能不得不依赖以下讨论一些其他选项。

为了展示 Cheerio 的强大功能,我们将尝试爬取 Reddit 中的 r/programming 论坛以获取帖子标题列表。

首先,运行以下命令安装 Cheerio 和 axios:npm install Cheerio axios。然后创建一个名为 crawler.js 的新文件并复制/粘贴以下代码:

1const axios = require('axios');

2const cheerio = require('cheerio');

3const getPostTitles = async () => {

4 try {

5 const { data } = await axios.get(

6 'https://old.reddit.com/r/programming/'

7 );

8 const $ = cheerio.load(data);

9 const postTitles = [];

10 $('div > p.title > a').each((_idx, el) => {

11 const postTitle = $(el).text()

12 postTitles.push(postTitle)

13 });

14 return postTitles;

15 } catch (error) {

16 throw error;

17 }

18};

19getPostTitles()

20.then((postTitles) => console.log(postTitles));

21