网页抓取数据 免费

网页抓取数据 免费(网页抓取数据免费方法多种多样,整合多套能够转换的网站网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-11-14 00:01

网页抓取数据免费方法多种多样,整合多套能够转换的网站网站便于定制自动化抓取,如。anyway。小码哥整理了部分共有8套(前端网站,常用)1.可汗学院最大的视频学习网站2.扇贝单词分享提供各种英语学习资料,你可以使用扇贝打卡,也可以搜集自己喜欢的词汇卡片或单词库。有一个好评最多的版本。3.沪江开心词场每日打卡提高词汇量,也推出了买词典,买红砖或买小词典的优惠活动。

4.21天搞定考研词汇一个提供金融、经济、计算机、心理学等领域词汇相关的自学网站。每天一个金融词汇小卡片,帮助您更好地记忆金融词汇。如:金融知识卡片提供了简单有趣的金融数据分析5.simplex-im官方推荐的一个英语学习网站。内容涵盖四六级、考研,托福、雅思。里面有好多不同的题目供选择。6.每日英语听力网站提供包括chinadaily在内的英语新闻,每天英语听力点播(从ft中文网收听)或听写。

7.沪江英语网专注于提供实用工具,多种学习资源,视频学习,听力学习,有quizlet,付费阅读。8.每日一句每天推送四六级句子,适合有基础的高中学生。(搞笑语句类)内容:每日一句(所有资源均收费)资源分享(有水印)end扫码关注小码哥。

1.传智播客学院(这个我深有体会,如今时间紧张,我用过,体验很好,值得学习,但是网上也有很多人说不靠谱)2.百度传课(只推荐三个大网站,百度传课、网易公开课、腾讯公开课)3.多贝网(针对,也有电台类)4.优米网(针对视频)5.非凡教程大全(针对视频)6.我要自学网(开学季找好多教程,还有课堂视频)7.小站教育(很不错)8.英语流利说(从四六级、托福、托业、雅思考试以及口语学习)9.中国大学mooc(可以看公开课和慕课,分类很细致)10.51自学网(有很多优秀的公开课和慕课)11.网易公开课(找网易公开课的网站)12.中国大学mooc(可以找公开课的网站)13.东吴慕课网(基本所有的网课都有)14.百度网盘(百度网盘,网盘大神的居住地)15.喜马拉雅fm(听各种名人讲课,尤其是ppt课和万门大学等,很受启发)16.荔枝fm(每天都有新话题,听各类名人讲课,尤其是罗振宇,任何人学到东西都是收获)17.音悦台(注意,现在已经从幕后走向台前了,有很多专业音乐人做专辑,可以看一些资源)18.暴风影音(可以看盗版片)19.海绵学院(分享给同学,自己再下载几部,现在正在这么干,比如大话西游2,星球大战7等)20.万能mp3搜索(听见自己的声音,可以算是一个黑科技,虽然一直知道,但一直没想到。)21.非凡大数。 查看全部

网页抓取数据 免费(网页抓取数据免费方法多种多样,整合多套能够转换的网站网站)

网页抓取数据免费方法多种多样,整合多套能够转换的网站网站便于定制自动化抓取,如。anyway。小码哥整理了部分共有8套(前端网站,常用)1.可汗学院最大的视频学习网站2.扇贝单词分享提供各种英语学习资料,你可以使用扇贝打卡,也可以搜集自己喜欢的词汇卡片或单词库。有一个好评最多的版本。3.沪江开心词场每日打卡提高词汇量,也推出了买词典,买红砖或买小词典的优惠活动。

4.21天搞定考研词汇一个提供金融、经济、计算机、心理学等领域词汇相关的自学网站。每天一个金融词汇小卡片,帮助您更好地记忆金融词汇。如:金融知识卡片提供了简单有趣的金融数据分析5.simplex-im官方推荐的一个英语学习网站。内容涵盖四六级、考研,托福、雅思。里面有好多不同的题目供选择。6.每日英语听力网站提供包括chinadaily在内的英语新闻,每天英语听力点播(从ft中文网收听)或听写。

7.沪江英语网专注于提供实用工具,多种学习资源,视频学习,听力学习,有quizlet,付费阅读。8.每日一句每天推送四六级句子,适合有基础的高中学生。(搞笑语句类)内容:每日一句(所有资源均收费)资源分享(有水印)end扫码关注小码哥。

1.传智播客学院(这个我深有体会,如今时间紧张,我用过,体验很好,值得学习,但是网上也有很多人说不靠谱)2.百度传课(只推荐三个大网站,百度传课、网易公开课、腾讯公开课)3.多贝网(针对,也有电台类)4.优米网(针对视频)5.非凡教程大全(针对视频)6.我要自学网(开学季找好多教程,还有课堂视频)7.小站教育(很不错)8.英语流利说(从四六级、托福、托业、雅思考试以及口语学习)9.中国大学mooc(可以看公开课和慕课,分类很细致)10.51自学网(有很多优秀的公开课和慕课)11.网易公开课(找网易公开课的网站)12.中国大学mooc(可以找公开课的网站)13.东吴慕课网(基本所有的网课都有)14.百度网盘(百度网盘,网盘大神的居住地)15.喜马拉雅fm(听各种名人讲课,尤其是ppt课和万门大学等,很受启发)16.荔枝fm(每天都有新话题,听各类名人讲课,尤其是罗振宇,任何人学到东西都是收获)17.音悦台(注意,现在已经从幕后走向台前了,有很多专业音乐人做专辑,可以看一些资源)18.暴风影音(可以看盗版片)19.海绵学院(分享给同学,自己再下载几部,现在正在这么干,比如大话西游2,星球大战7等)20.万能mp3搜索(听见自己的声音,可以算是一个黑科技,虽然一直知道,但一直没想到。)21.非凡大数。

网页抓取数据 免费(Windows,OSX及Linux操作系统或mobi格式的在线阅读)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-11-13 00:18

自从我买了kindle,我就一直在想如何最大限度地发挥它的功效。虽然可供购买的书籍很多,网上也有很多免费的电子书,但还是有很多有趣的内容以网页的形式出现。例如,O'Reilly Atlas 提供了很多电子书,但只提供免费在线阅读;此外,许多材料或文件只是网络形式。所以我希望将这些网上资料以某种方式转换成epub或者mobi格式,以便在kindle上阅读。本文文章介绍了如何使用calibre并编写少量代码来实现这一目标。

Calibre 简介

Calibre 是一款免费的电子书管理工具,兼容 Windows、OS X 和 Linux。令人欣慰的是,除了GUI,calibre 还提供了很多命令行工具。ebook-convert 命令可以基于用户编写的食谱。该文件(实际上是python代码)抓取指定页面的内容,生成mobi等格式的电子书。爬取行为可以通过编写recipe来定制,以适应不同的网页结构。

安装口径

Calibre的下载地址是,您可以根据自己的操作系统下载相应的安装程序。

如果是Linux操作系统,也可以通过软件仓库安装:

Archlinux:

pacman -S calibre

Debian/Ubuntu:

apt-get install calibre

红帽/Fedora/CentOS:

yum -y install calibre

请注意,如果您使用 OSX,则需要单独安装命令行工具。

抓取网页以生成电子书

下面以Git Pocket Guide为例,说明如何通过calibre从网页生成电子书。

找到索引页

要爬取整本书,首先要找到索引页。这个页面一般是目录,也就是目录页面,其中每个目录链接都连接到相应的内容页面。在生成电子书时,索引页会指导抓取哪些页面以及内容组织的顺序。在这个例子中,索引页是。

写食谱

食谱是一个带有食谱扩展名的脚本。内容其实是一段python代码,定义了calibre爬取页面的范围和行为。以下是爬取 Git Pocket Guide 的秘籍:

from calibre.web.feeds.recipes import BasicNewsRecipe

class Git_Pocket_Guide(BasicNewsRecipe):

title = 'Git Pocket Guide'

description = ''

cover_url = 'http://akamaicovers.oreilly.co ... 39%3B

url_prefix = 'http://chimera.labs.oreilly.co ... 39%3B

no_stylesheets = True

keep_only_tags = [{ 'class': 'chapter' }]

def get_title(self, link):

return link.contents[0].strip()

def parse_index(self):

soup = self.index_to_soup(self.url_prefix + 'index.html')

div = soup.find('div', { 'class': 'toc' })

articles = []

for link in div.findAll('a'):

if '#' in link['href']:

continue

if not 'ch' in link['href']:

continue

til = self.get_title(link)

url = self.url_prefix + link['href']

a = { 'title': til, 'url': url }

articles.append(a)

ans = [('Git_Pocket_Guide', articles)]

return ans

下面解释了代码的不同部分。

整体结构

一般来说,一个recipe是一个python类,但是这个类必须继承calibre.web.feeds.recipes.BasicNewsRecipe。

解析索引

整个recipe的核心方法是parse_index,这也是recipes必须实现的唯一方法。该方法的目标是通过分析索引页的内容,返回一个稍微复杂一些的数据结构(稍后介绍)。这个数据结构定义了整个电子书的内容和内容组织顺序。

整体属性设置

在类的开头,定义了一些全局属性:

title = 'Git Pocket Guide'

description = ''

cover_url = 'http://akamaicovers.oreilly.co ... 39%3B

url_prefix = 'http://chimera.labs.oreilly.co ... 39%3B

no_stylesheets = True

keep_only_tags = [{ 'class': 'chapter' }]

parse_index 返回值

下面通过分析索引页来描述parse_index需要返回的数据结构。

整体的返回数据结构是一个列表,其中每个元素是一个元组,一个元组代表一个卷。在这个例子中,只有一个卷,所以列表中只有一个元组。

每个元组有两个元素,第一个元素是卷名,第二个元素是一个列表,列表中的每个元素都是一个映射,代表一个章节(chapter),映射中有两个元素: title 和 url , Title是章节的标题,url是章节所在的内容页面的url。

Calibre 会根据parse_index 的返回结果对整本书进行爬取和组织,并会自行爬取处理内容内外的图片。

整个parse_index使用soup解析索引页,生成上述数据结构。

更多的

以上是最基本的食谱。如果想了解更多使用方法,可以参考API文档。

生成手机

写好菜谱后,可以在命令行中使用以下命令生成电子书:

ebook-convert Git_Pocket_Guide.recipe Git_Pocket_Guide.mobi

您可以生成mobi 格式的电子书。ebook-convert 会爬取相关内容,根据配方代码自行组织结构。

最终效果

下面是在kindle上看到的效果。

内容

内容一

内容二

带图片的页面

实际效果

我的食谱仓库

我在github上做了一个kindle-open-books,里面有一些菜谱,是我自己写的,其他同学贡献的。欢迎任何人提供食谱。 查看全部

网页抓取数据 免费(Windows,OSX及Linux操作系统或mobi格式的在线阅读)

自从我买了kindle,我就一直在想如何最大限度地发挥它的功效。虽然可供购买的书籍很多,网上也有很多免费的电子书,但还是有很多有趣的内容以网页的形式出现。例如,O'Reilly Atlas 提供了很多电子书,但只提供免费在线阅读;此外,许多材料或文件只是网络形式。所以我希望将这些网上资料以某种方式转换成epub或者mobi格式,以便在kindle上阅读。本文文章介绍了如何使用calibre并编写少量代码来实现这一目标。

Calibre 简介

Calibre 是一款免费的电子书管理工具,兼容 Windows、OS X 和 Linux。令人欣慰的是,除了GUI,calibre 还提供了很多命令行工具。ebook-convert 命令可以基于用户编写的食谱。该文件(实际上是python代码)抓取指定页面的内容,生成mobi等格式的电子书。爬取行为可以通过编写recipe来定制,以适应不同的网页结构。

安装口径

Calibre的下载地址是,您可以根据自己的操作系统下载相应的安装程序。

如果是Linux操作系统,也可以通过软件仓库安装:

Archlinux:

pacman -S calibre

Debian/Ubuntu:

apt-get install calibre

红帽/Fedora/CentOS:

yum -y install calibre

请注意,如果您使用 OSX,则需要单独安装命令行工具。

抓取网页以生成电子书

下面以Git Pocket Guide为例,说明如何通过calibre从网页生成电子书。

找到索引页

要爬取整本书,首先要找到索引页。这个页面一般是目录,也就是目录页面,其中每个目录链接都连接到相应的内容页面。在生成电子书时,索引页会指导抓取哪些页面以及内容组织的顺序。在这个例子中,索引页是。

写食谱

食谱是一个带有食谱扩展名的脚本。内容其实是一段python代码,定义了calibre爬取页面的范围和行为。以下是爬取 Git Pocket Guide 的秘籍:

from calibre.web.feeds.recipes import BasicNewsRecipe

class Git_Pocket_Guide(BasicNewsRecipe):

title = 'Git Pocket Guide'

description = ''

cover_url = 'http://akamaicovers.oreilly.co ... 39%3B

url_prefix = 'http://chimera.labs.oreilly.co ... 39%3B

no_stylesheets = True

keep_only_tags = [{ 'class': 'chapter' }]

def get_title(self, link):

return link.contents[0].strip()

def parse_index(self):

soup = self.index_to_soup(self.url_prefix + 'index.html')

div = soup.find('div', { 'class': 'toc' })

articles = []

for link in div.findAll('a'):

if '#' in link['href']:

continue

if not 'ch' in link['href']:

continue

til = self.get_title(link)

url = self.url_prefix + link['href']

a = { 'title': til, 'url': url }

articles.append(a)

ans = [('Git_Pocket_Guide', articles)]

return ans

下面解释了代码的不同部分。

整体结构

一般来说,一个recipe是一个python类,但是这个类必须继承calibre.web.feeds.recipes.BasicNewsRecipe。

解析索引

整个recipe的核心方法是parse_index,这也是recipes必须实现的唯一方法。该方法的目标是通过分析索引页的内容,返回一个稍微复杂一些的数据结构(稍后介绍)。这个数据结构定义了整个电子书的内容和内容组织顺序。

整体属性设置

在类的开头,定义了一些全局属性:

title = 'Git Pocket Guide'

description = ''

cover_url = 'http://akamaicovers.oreilly.co ... 39%3B

url_prefix = 'http://chimera.labs.oreilly.co ... 39%3B

no_stylesheets = True

keep_only_tags = [{ 'class': 'chapter' }]

parse_index 返回值

下面通过分析索引页来描述parse_index需要返回的数据结构。

整体的返回数据结构是一个列表,其中每个元素是一个元组,一个元组代表一个卷。在这个例子中,只有一个卷,所以列表中只有一个元组。

每个元组有两个元素,第一个元素是卷名,第二个元素是一个列表,列表中的每个元素都是一个映射,代表一个章节(chapter),映射中有两个元素: title 和 url , Title是章节的标题,url是章节所在的内容页面的url。

Calibre 会根据parse_index 的返回结果对整本书进行爬取和组织,并会自行爬取处理内容内外的图片。

整个parse_index使用soup解析索引页,生成上述数据结构。

更多的

以上是最基本的食谱。如果想了解更多使用方法,可以参考API文档。

生成手机

写好菜谱后,可以在命令行中使用以下命令生成电子书:

ebook-convert Git_Pocket_Guide.recipe Git_Pocket_Guide.mobi

您可以生成mobi 格式的电子书。ebook-convert 会爬取相关内容,根据配方代码自行组织结构。

最终效果

下面是在kindle上看到的效果。

内容

内容一

内容二

带图片的页面

实际效果

我的食谱仓库

我在github上做了一个kindle-open-books,里面有一些菜谱,是我自己写的,其他同学贡献的。欢迎任何人提供食谱。

网页抓取数据 免费(一抓一大把,但是好不容易找到点击的可以粘贴的标题)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-11-11 09:02

网页抓取数据免费公众号的标题一抓一大把,但是好不容易找到点击的可以粘贴的标题一抓一大把,更要命的是没有常规的搜索标签。爬虫项目找人写都很难找人写好的程序,大部分也都是有服务器,不是自己写个。今天好不容易自己又写了一个爬虫,那就是爬行干货大全,纯手工构造,纯手工一个个爬,从0一步步实现,完成两个工具:apistore【行业分类】和秒接云【企业服务】爬虫项目由我一个人完成,程序整体思路还是采用传统爬虫,从百度直接爬取规则,结合他人实现的写出自己的爬虫。

程序全程svn部署,基于github。此程序由手工构思,可能不是最完美的,但是原理本人已经清楚,不再细细推敲。只是把整体思路理一下,不写详细步骤,只是提供一个思路,下一篇详细讲解一些细节,欢迎同频交流。

是时候放出这张图了!

可以用爬虫工具,比如觅元素或者萝卜书摘,

不建议使用爬虫工具,直接用手工爬。

手工。如果需要定制别人的标题,那你自己用百度搜就可以了。

推荐我最喜欢的爬虫工具:top24。

搜一下猴子搜库,有现成的官方公众号的标题标签抓取工具,个人觉得太占空间了,而且抓取过程中几次崩溃,

可以先试试公众号标题采集工具,然后就上github找爬虫, 查看全部

网页抓取数据 免费(一抓一大把,但是好不容易找到点击的可以粘贴的标题)

网页抓取数据免费公众号的标题一抓一大把,但是好不容易找到点击的可以粘贴的标题一抓一大把,更要命的是没有常规的搜索标签。爬虫项目找人写都很难找人写好的程序,大部分也都是有服务器,不是自己写个。今天好不容易自己又写了一个爬虫,那就是爬行干货大全,纯手工构造,纯手工一个个爬,从0一步步实现,完成两个工具:apistore【行业分类】和秒接云【企业服务】爬虫项目由我一个人完成,程序整体思路还是采用传统爬虫,从百度直接爬取规则,结合他人实现的写出自己的爬虫。

程序全程svn部署,基于github。此程序由手工构思,可能不是最完美的,但是原理本人已经清楚,不再细细推敲。只是把整体思路理一下,不写详细步骤,只是提供一个思路,下一篇详细讲解一些细节,欢迎同频交流。

是时候放出这张图了!

可以用爬虫工具,比如觅元素或者萝卜书摘,

不建议使用爬虫工具,直接用手工爬。

手工。如果需要定制别人的标题,那你自己用百度搜就可以了。

推荐我最喜欢的爬虫工具:top24。

搜一下猴子搜库,有现成的官方公众号的标题标签抓取工具,个人觉得太占空间了,而且抓取过程中几次崩溃,

可以先试试公众号标题采集工具,然后就上github找爬虫,

网页抓取数据 免费(绿色免费、功能强大、支持各种网页表单一键填写辅助工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-11-10 19:18

风悦网页批量填写数据提取软件是一款一键填写网页表单的专用工具。不管是注册用户、登录账号密码、评论、发帖等,这些都是提交表单的方式。这里是小编给大家带来的工具,绿色免费,功能强大,支持各种网页类型,支持各种元素控件等,相比其他同类软件,准确率更高!

基本介绍

其他填表工具一般不支持:多框页面(frame)、多选列表、HTML文本(iframe)输入法,本软件一般都能正确填写。本软件不仅可以用于一般办公填表,还可以扩展为批量注册、投票、留言、商品秒杀、舆情控制、征信、抢车牌等工具。

特征

支持从Excel和ACCESS文件中读取数据填写表格,并可根据当前表格生成Xls文件,方便批量录入

支持下载指定文件和抓取网页文本内容

支持填充多帧页面中的控件元素

支持嵌入frame iframe的页面中控件元素的填充

支持网页结构分析,显示控件的描述,方便分析和修改控件的值

支持各种页面控件元素的填充:

支持文本输入框输入/textarea

支持单选、多选列表多选

支持多选框收音机

支持收音机复选框

支持填写级联下拉菜单

支持填写无ID控制 查看全部

网页抓取数据 免费(绿色免费、功能强大、支持各种网页表单一键填写辅助工具)

风悦网页批量填写数据提取软件是一款一键填写网页表单的专用工具。不管是注册用户、登录账号密码、评论、发帖等,这些都是提交表单的方式。这里是小编给大家带来的工具,绿色免费,功能强大,支持各种网页类型,支持各种元素控件等,相比其他同类软件,准确率更高!

基本介绍

其他填表工具一般不支持:多框页面(frame)、多选列表、HTML文本(iframe)输入法,本软件一般都能正确填写。本软件不仅可以用于一般办公填表,还可以扩展为批量注册、投票、留言、商品秒杀、舆情控制、征信、抢车牌等工具。

特征

支持从Excel和ACCESS文件中读取数据填写表格,并可根据当前表格生成Xls文件,方便批量录入

支持下载指定文件和抓取网页文本内容

支持填充多帧页面中的控件元素

支持嵌入frame iframe的页面中控件元素的填充

支持网页结构分析,显示控件的描述,方便分析和修改控件的值

支持各种页面控件元素的填充:

支持文本输入框输入/textarea

支持单选、多选列表多选

支持多选框收音机

支持收音机复选框

支持填写级联下拉菜单

支持填写无ID控制

网页抓取数据 免费(网页抓取数据免费教程,包括数据获取,不能指望有特别好的质量)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-11-09 10:02

网页抓取数据免费教程,包括数据获取,数据处理,

1、fiddler专业版:抓取网页emmmm有网友建议我更换nec的专业版或者火狐的专业版。不过,我觉得这些都是学习免费学习,不能指望有特别好的质量,

2、appium+mobx:抓取文字资源应该是最好用的,但是我还没在某些项目中用到。但是会appium之后还可以在嵌入一个electron类再来一个ta,另外就是上次有人说github不支持动态加载数据,但是我觉得动态加载数据可以用android的viewresult来完成(如果没有的话coding一下androidc++),没必要去动java的,它直接支持javaio,javaweb的webservices的。

总之比ga要好,比如我查了一下,其它的就免费版来说,基本功能差不多,说不定ga连基本功能都没有,所以这里建议大家用ga还是用mobx,appium或者fiddler都不要用。

3、pip:免费版pip大法好,特别是手机客户端。能实现所有方便我们上网、爬虫的代码,比如我拿下来一个商品分类的商品的价格,但是我要去获取上图的json数据,怎么办?直接pipinstallpip就好。

4、scrapy:比较小众,可以分析python爬虫,但是没有官方的注册,需要搭建。支持java和nodejs两种开发语言,可以用pip安装,他们都是基于requests库的,很多公司用它来做爬虫,会先从浏览器的requests读取一段json数据,然后直接丢进去,然后再用for循环遍历完整的api数据,不想自己玩不会用得。

5、httpclient:国内外都很多教程,可以分析python爬虫。

6、beautifulsoup:beautifulsoup是python内置的模块,这个模块由于官方语言是python,这个模块在python内置内,其他语言没有本地化过来,这个模块只是作为python的一个基础库,python之外不会有使用它的机会。所以,这个模块本身并不实用,是python开发的语言使用,仅仅可以分析页面上python抓取页面返回数据时的base64编码,还可以搞定github上的githubpage分析。

7、xmlapis:的返回,一些大公司使用的时候会有一些限制,现在没有找到怎么我总结到这里了,因为要我那么去多去学这些技术,我的时间有限,更没有条件学。我的经验是用python的思想和方法去一层一层套上代码,比如我想先爬,想要获取那些店铺的id,那就再走一遍上一步,先去抓一下网页上的id。

那如果要搞定返回json数据呢?也是如此,搞定一个url再去操作整个页面就可以搞定返回json数据。更多资料。 查看全部

网页抓取数据 免费(网页抓取数据免费教程,包括数据获取,不能指望有特别好的质量)

网页抓取数据免费教程,包括数据获取,数据处理,

1、fiddler专业版:抓取网页emmmm有网友建议我更换nec的专业版或者火狐的专业版。不过,我觉得这些都是学习免费学习,不能指望有特别好的质量,

2、appium+mobx:抓取文字资源应该是最好用的,但是我还没在某些项目中用到。但是会appium之后还可以在嵌入一个electron类再来一个ta,另外就是上次有人说github不支持动态加载数据,但是我觉得动态加载数据可以用android的viewresult来完成(如果没有的话coding一下androidc++),没必要去动java的,它直接支持javaio,javaweb的webservices的。

总之比ga要好,比如我查了一下,其它的就免费版来说,基本功能差不多,说不定ga连基本功能都没有,所以这里建议大家用ga还是用mobx,appium或者fiddler都不要用。

3、pip:免费版pip大法好,特别是手机客户端。能实现所有方便我们上网、爬虫的代码,比如我拿下来一个商品分类的商品的价格,但是我要去获取上图的json数据,怎么办?直接pipinstallpip就好。

4、scrapy:比较小众,可以分析python爬虫,但是没有官方的注册,需要搭建。支持java和nodejs两种开发语言,可以用pip安装,他们都是基于requests库的,很多公司用它来做爬虫,会先从浏览器的requests读取一段json数据,然后直接丢进去,然后再用for循环遍历完整的api数据,不想自己玩不会用得。

5、httpclient:国内外都很多教程,可以分析python爬虫。

6、beautifulsoup:beautifulsoup是python内置的模块,这个模块由于官方语言是python,这个模块在python内置内,其他语言没有本地化过来,这个模块只是作为python的一个基础库,python之外不会有使用它的机会。所以,这个模块本身并不实用,是python开发的语言使用,仅仅可以分析页面上python抓取页面返回数据时的base64编码,还可以搞定github上的githubpage分析。

7、xmlapis:的返回,一些大公司使用的时候会有一些限制,现在没有找到怎么我总结到这里了,因为要我那么去多去学这些技术,我的时间有限,更没有条件学。我的经验是用python的思想和方法去一层一层套上代码,比如我想先爬,想要获取那些店铺的id,那就再走一遍上一步,先去抓一下网页上的id。

那如果要搞定返回json数据呢?也是如此,搞定一个url再去操作整个页面就可以搞定返回json数据。更多资料。

网页抓取数据 免费(就是软件开发怎样提取网页里数据?最新的工作进度动态!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2021-11-08 03:02

免费用户也想看分时DDX和DDY(大智慧用户)。我的目标是通过 VC++ 从网页中提取数据并将它们制作成 DLL 文件。我只有一步之遥。如何从网页中提取数据?

118楼发布最新工作进展,请及时关注本DDX软件的最新进展!!!

我有三个文件:

1、IT_DDE.FNC-------里面有3个公式指标。不介绍,什么都看不到;

导入时注意公式路径:必须是:D:\dzh2,

否则,我在哪里可以在计算机上找到您的公式?

2、n.txt------------是大智慧DDE数据,不说重要性;

3、FxjFunc.dll------用于调用前两项1、和2、。

具体用法是:

步骤(1)首先将IT_DDE.FNC复制到D:\dzh2\IT_DDE.FNC,并引入指标IT_DDE.FNC;

(2)复制n.txt到D:\dzh2\n.txt;

(3)最后把FxjFunc.dll复制到你的大智慧安装目录:\FxjFunc.dll。

例如:复制到大智慧安装目录(D:\dzh2\FxjFunc.dll);

也许是这样,但实际上什么都可以做:将其复制到大智慧安装目录(C:\Program Files\Stock\dzh2\FxjFunc.dll); 查看全部

网页抓取数据 免费(就是软件开发怎样提取网页里数据?最新的工作进度动态!)

免费用户也想看分时DDX和DDY(大智慧用户)。我的目标是通过 VC++ 从网页中提取数据并将它们制作成 DLL 文件。我只有一步之遥。如何从网页中提取数据?

118楼发布最新工作进展,请及时关注本DDX软件的最新进展!!!

我有三个文件:

1、IT_DDE.FNC-------里面有3个公式指标。不介绍,什么都看不到;

导入时注意公式路径:必须是:D:\dzh2,

否则,我在哪里可以在计算机上找到您的公式?

2、n.txt------------是大智慧DDE数据,不说重要性;

3、FxjFunc.dll------用于调用前两项1、和2、。

具体用法是:

步骤(1)首先将IT_DDE.FNC复制到D:\dzh2\IT_DDE.FNC,并引入指标IT_DDE.FNC;

(2)复制n.txt到D:\dzh2\n.txt;

(3)最后把FxjFunc.dll复制到你的大智慧安装目录:\FxjFunc.dll。

例如:复制到大智慧安装目录(D:\dzh2\FxjFunc.dll);

也许是这样,但实际上什么都可以做:将其复制到大智慧安装目录(C:\Program Files\Stock\dzh2\FxjFunc.dll);

网页抓取数据 免费(本文就用Java给大家演示怎样抓取站点的数据:(1))

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-11-07 17:05

原文链接:

有时因为各种原因,我们需要从某个站点采集数据,但是因为不同站点显示的数据略有不同!

本文使用Java向大家展示如何抓取网站数据:(1)抓取原创网页数据;(2)抓取网页Javascript返回的数据。

一、 抓取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页,输入IP:111.142.55.73,点击查询按钮,可以看到网页显示的结果:

第二步:查看网页的源码,我们在源码中看到这一段:

由此可以看出,再次请求网页后,显示查询的结果。

查询后看网页地址:

换句话说,我们只能通过访问这种 URL 来获取 ip 查询的结果。接下来看代码:

public void captureHtml(String ip) throws Exception {

String strURL = "http://ip.chinaz.com/?IP=" + ip;

URL url = new URL(strURL);

HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

InputStreamReader input = new InputStreamReader(httpConn

.getInputStream(), "utf-8");

BufferedReader bufReader = new BufferedReader(input);

String line = "";

StringBuilder contentBuf = new StringBuilder();

while ((line = bufReader.readLine()) != null) {

contentBuf.append(line);

}

String buf = contentBuf.toString();

int beginIx = buf.indexOf("查询结果[");

int endIx = buf.indexOf("上面四项依次显示的是");

String result = buf.substring(beginIx, endIx);

System.out.println("captureHtml()的结果:\n" + result);

}

使用HttpURLConnection连接站点,使用bufReader保存网页返回的数据,然后通过自己定义的解析方法显示结果。

这里我只是随便解析了一下,想要解析准确,就需要自己处理了。

分析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建省漳州市手机

二、 抓取网页的 JavaScript 返回的结果。

有时,网站为了保护自己的数据,不会直接在网页的源代码中返回数据,而是使用异步的方式用JS返回数据,这样可以避免网站数据被诸如搜索引擎。

首先看这个页面:

我用第一种方法查看网页源代码,但是没有找到运单的跟踪信息,因为是通过JS获取的结果。

但是有时候我们非常需要获取JS数据,这个时候我们该怎么办呢?

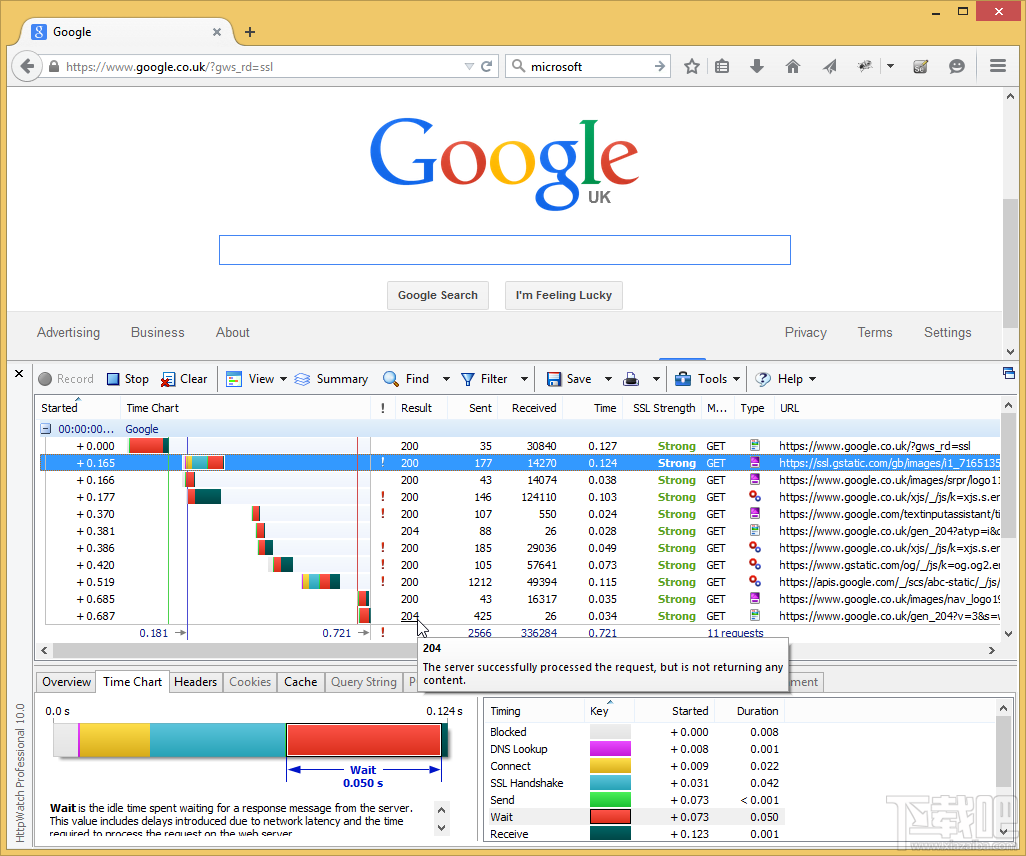

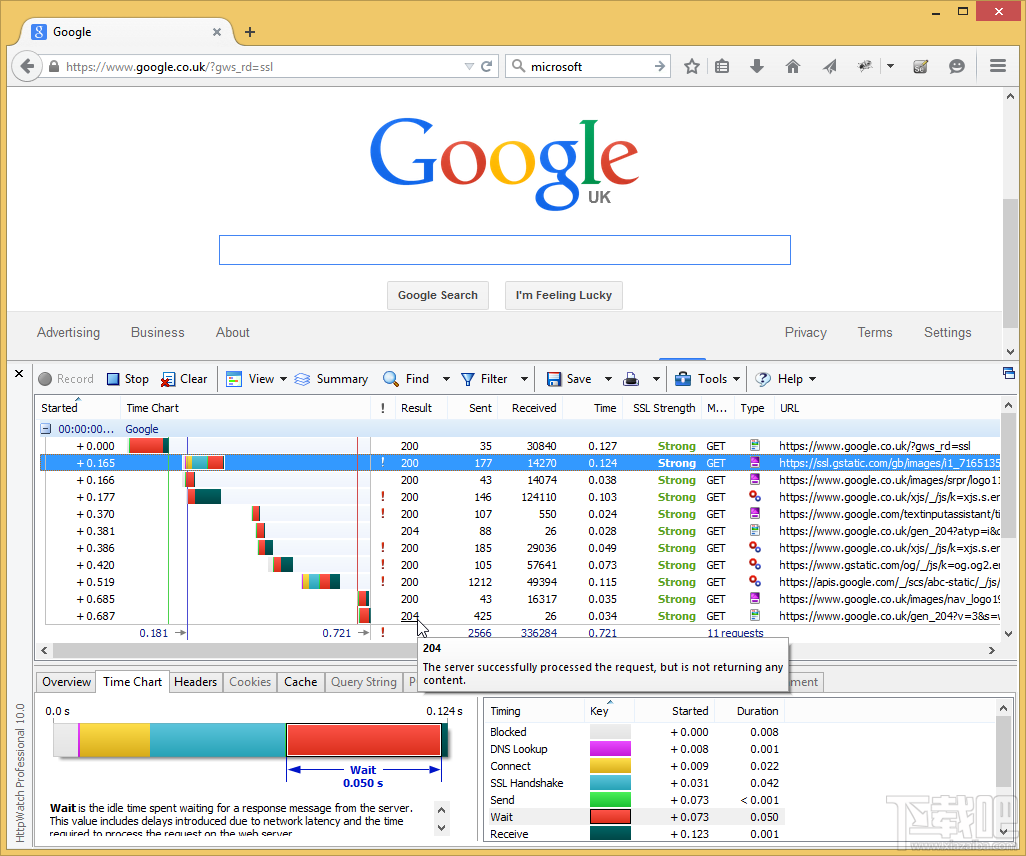

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以拦截Http的交互内容,我们使用这个工具来达到我们的目的。

先点击开始按钮后,它开始监控网页的交互行为。

我们打开网页:,可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便的查看JS的结果,我们先清空数据,然后输入快递单号:7,点击查询按钮,然后查看HTTP Analyzer的结果:

这是点击查询按钮后HTTP Analyzer的结果。让我们继续检查:

从上两图可以看出,HTTP Analyzer可以拦截JS返回的数据,并在Response Content中展示。同时可以看到JS请求的网页地址。

在这种情况下,我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为来获取数据,即我们只需要访问JS请求的网页地址就可以获取数据。当然,前提是数据没有加密。记下 JS 请求的 URL:

然后让程序请求这个页面的结果!

这是代码:

public void captureJavascript(String postid) throws Exception {

String strURL = "http://www.kiees.cn/sf.php?wen=" + postid

+ "&channel=&rnd=0";

URL url = new URL(strURL);

HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

InputStreamReader input = new InputStreamReader(httpConn

.getInputStream(), "utf-8");

BufferedReader bufReader = new BufferedReader(input);

String line = "";

StringBuilder contentBuf = new StringBuilder();

while ((line = bufReader.readLine()) != null) {

contentBuf.append(line);

}

System.out.println("captureJavascript()的结果:\n" + contentBuf.toString());

}

可以看到,抓取JS的方式和抓取原创网页的代码完全一样,只是做了一个解析JS的过程。

下面是程序运行的结果:

captureJavascript() 的结果:

运单跟踪信息 [7]

这些数据就是JS返回的结果,我们的目的就达到了!

希望这篇文章能对需要的朋友有所帮助。如果您需要程序源代码,请点击这里下载! 查看全部

网页抓取数据 免费(本文就用Java给大家演示怎样抓取站点的数据:(1))

原文链接:

有时因为各种原因,我们需要从某个站点采集数据,但是因为不同站点显示的数据略有不同!

本文使用Java向大家展示如何抓取网站数据:(1)抓取原创网页数据;(2)抓取网页Javascript返回的数据。

一、 抓取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页,输入IP:111.142.55.73,点击查询按钮,可以看到网页显示的结果:

第二步:查看网页的源码,我们在源码中看到这一段:

由此可以看出,再次请求网页后,显示查询的结果。

查询后看网页地址:

换句话说,我们只能通过访问这种 URL 来获取 ip 查询的结果。接下来看代码:

public void captureHtml(String ip) throws Exception {

String strURL = "http://ip.chinaz.com/?IP=" + ip;

URL url = new URL(strURL);

HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

InputStreamReader input = new InputStreamReader(httpConn

.getInputStream(), "utf-8");

BufferedReader bufReader = new BufferedReader(input);

String line = "";

StringBuilder contentBuf = new StringBuilder();

while ((line = bufReader.readLine()) != null) {

contentBuf.append(line);

}

String buf = contentBuf.toString();

int beginIx = buf.indexOf("查询结果[");

int endIx = buf.indexOf("上面四项依次显示的是");

String result = buf.substring(beginIx, endIx);

System.out.println("captureHtml()的结果:\n" + result);

}

使用HttpURLConnection连接站点,使用bufReader保存网页返回的数据,然后通过自己定义的解析方法显示结果。

这里我只是随便解析了一下,想要解析准确,就需要自己处理了。

分析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建省漳州市手机

二、 抓取网页的 JavaScript 返回的结果。

有时,网站为了保护自己的数据,不会直接在网页的源代码中返回数据,而是使用异步的方式用JS返回数据,这样可以避免网站数据被诸如搜索引擎。

首先看这个页面:

我用第一种方法查看网页源代码,但是没有找到运单的跟踪信息,因为是通过JS获取的结果。

但是有时候我们非常需要获取JS数据,这个时候我们该怎么办呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以拦截Http的交互内容,我们使用这个工具来达到我们的目的。

先点击开始按钮后,它开始监控网页的交互行为。

我们打开网页:,可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便的查看JS的结果,我们先清空数据,然后输入快递单号:7,点击查询按钮,然后查看HTTP Analyzer的结果:

这是点击查询按钮后HTTP Analyzer的结果。让我们继续检查:

从上两图可以看出,HTTP Analyzer可以拦截JS返回的数据,并在Response Content中展示。同时可以看到JS请求的网页地址。

在这种情况下,我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为来获取数据,即我们只需要访问JS请求的网页地址就可以获取数据。当然,前提是数据没有加密。记下 JS 请求的 URL:

然后让程序请求这个页面的结果!

这是代码:

public void captureJavascript(String postid) throws Exception {

String strURL = "http://www.kiees.cn/sf.php?wen=" + postid

+ "&channel=&rnd=0";

URL url = new URL(strURL);

HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();

InputStreamReader input = new InputStreamReader(httpConn

.getInputStream(), "utf-8");

BufferedReader bufReader = new BufferedReader(input);

String line = "";

StringBuilder contentBuf = new StringBuilder();

while ((line = bufReader.readLine()) != null) {

contentBuf.append(line);

}

System.out.println("captureJavascript()的结果:\n" + contentBuf.toString());

}

可以看到,抓取JS的方式和抓取原创网页的代码完全一样,只是做了一个解析JS的过程。

下面是程序运行的结果:

captureJavascript() 的结果:

运单跟踪信息 [7]

这些数据就是JS返回的结果,我们的目的就达到了!

希望这篇文章能对需要的朋友有所帮助。如果您需要程序源代码,请点击这里下载!

网页抓取数据 免费(如何用正则表达式对数据进行数据提取和数据分类汇总?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-11-07 17:04

在众多行业中,需要对行业数据进行分类汇总,及时对行业数据进行分析,为公司未来的发展提供良好的参考和横向比较。因此,在实际工作中,我们可能会遇到数据采集的概念。数据采集的最终目的是获取数据,提取有用的数据进行数据抽取和数据分类聚合。

很多人在第一次了解数据采集的时候,可能都无法上手,尤其是作为新手,感觉很茫然。因此,我想在这里分享我的经验,并希望与大家分享技术。如有不足之处请指正。写这篇的目的就是希望大家能一起成长。我也相信技术之间没有高低,只有互补,只有分享才能让彼此成长得更多。

以网页数据采集为例,我们经常要经过以下几个主要步骤:

①通过URL地址读取目标网页 ②获取网页源代码 ③通过网页源代码提取我们想要提取的目的数据 ④将数据格式转换为我们需要的数据。

这是示意图,希望大家理解

在了解了基本流程之后,我将通过一个案例来具体实现如何提取我们需要的数据。数据抽取可以使用正则表达式抽取,也可以使用httpclient+jsoup抽取。在此,httpclient+jsou 提取暂不解释。网页数据的做法以后会在httpclient+jsoup上具体讲解。在这里,我们将首先说明如何使用正则表达式提取数据。

我在这里找到了一个网站:我们要提取里面的数据。我们要提取的最终结果是产品型号、数量、报价和供应商。首先我们看到这个网站整页预览

接下来我们看一下网页的源码结构:

上面的源码可以清晰的看到整个网页的源码结构。接下来,我们将提取整个网页的数据。

import java.io.BufferedReader;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class HTMLPageParser {

public static void main(String[] args) throws Exception {

//目的网页URL地址

getURLInfo("http://www.ic.net.cn/userSite/ ... ot%3B,"utf-8");

}

public static List getURLInfo(String urlInfo,String charset) throws Exception {

//读取目的网页URL地址,获取网页源码

URL url = new URL(urlInfo);

HttpURLConnection httpUrl = (HttpURLConnection)url.openConnection();

InputStream is = httpUrl.getInputStream();

BufferedReader br = new BufferedReader(new InputStreamReader(is,"utf-8"));

StringBuilder sb = new StringBuilder();

String line;

while ((line = br.readLine()) != null) {

//这里是对链接进行处理

line = line.replaceAll("]*>", "");

//这里是对样式进行处理

line = line.replaceAll("]*>", "");

sb.append(line);

}

is.close();

br.close();

//获得网页源码

return getDataStructure(sb.toString().trim());

}

static Pattern proInfo

= Pattern.compile("(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)", Pattern.DOTALL);

private static List getDataStructure(String str) {

//运用正则表达式对获取的网页源码进行数据匹配,提取我们所要的数据,在以后的过程中,我们可以采用httpclient+jsoup,

//现在暂时运用正则表达式对数据进行抽取提取

String[] info = str.split("");

List list = new ArrayList();

for (String s : info) {

Matcher m = proInfo.matcher(s);

Product p = null;

if (m.find()) {

p = new Product();

//设置产品型号

String[] ss = m.group(1).trim().replace(" ", "").split(">");

p.setProStyle(ss[1]);

//设置产品数量

p.setProAmount(m.group(2).trim().replace(" ", ""));

//设置产品报价

p.setProPrice(m.group(4).trim().replace(" ", ""));

//设置产品供应商

p.setProSupplier(m.group(5).trim().replace(" ", ""));

list.add(p);

}

}

//这里对集合里面不是我们要提取的数据进行移除

list.remove(0);

for (int i = 0; i < list.size(); i++) {

System.out.println("产品型号:"+list.get(i).getProStyle()+",产品数量:"+list.get(i).getProAmount()

+",产品报价:"+list.get(i).getProPrice()+",产品供应商:"+list.get(i).getProSupplier());

}

return list;

}

}

class Product {

private String proStyle;//产品型号

private String proAmount;//产品数量

private String proPrice;//产品报价

private String proSupplier;//产品供应商

public String getProStyle() {

return proStyle;

}

public void setProStyle(String proStyle) {

this.proStyle = proStyle;

}

public String getProSupplier() {

return proSupplier;

}

public void setProSupplier(String proSupplier) {

this.proSupplier = proSupplier;

}

public String getProAmount() {

return proAmount;

}

public void setProAmount(String proAmount) {

this.proAmount = proAmount;

}

public String getProPrice() {

return proPrice;

}

public void setProPrice(String proPrice) {

this.proPrice = proPrice;

}

public Product() {

}

@Override

public String toString() {

return "Product [proAmount=" + proAmount + ", proPrice=" + proPrice

+ ", proStyle=" + proStyle + ", proSupplier=" + proSupplier

+ "]";

}

}

好了,运行上面的程序,我们得到如下数据,也就是我们最终想要得到的数据

成功获取数据,这就是我们想要得到的最终数据结果。最后要说的是,这里的这个网页比较简单,源数据可以在网页的源代码中看到,而这个方法就是在get方法中提交数据。,当真的是采集时,有些网页结构复杂,源码中可能没有我们想要提取的数据。以后我会介绍这点的解决方案。还有,我在这个页面采集的时候,只有采集当前页面的数据,还有分页的数据,这里就不解释了,只是一个提示,大家可以用多线程采集所有页面的当前数据,一个采集当前页面数据和一个翻页动作可以通过线程完成采集所有数据。

我们匹配的数据可能在项目的实际开发中,我们需要将提取的数据存储起来,方便我们接下来的数据查询操作。 查看全部

网页抓取数据 免费(如何用正则表达式对数据进行数据提取和数据分类汇总?)

在众多行业中,需要对行业数据进行分类汇总,及时对行业数据进行分析,为公司未来的发展提供良好的参考和横向比较。因此,在实际工作中,我们可能会遇到数据采集的概念。数据采集的最终目的是获取数据,提取有用的数据进行数据抽取和数据分类聚合。

很多人在第一次了解数据采集的时候,可能都无法上手,尤其是作为新手,感觉很茫然。因此,我想在这里分享我的经验,并希望与大家分享技术。如有不足之处请指正。写这篇的目的就是希望大家能一起成长。我也相信技术之间没有高低,只有互补,只有分享才能让彼此成长得更多。

以网页数据采集为例,我们经常要经过以下几个主要步骤:

①通过URL地址读取目标网页 ②获取网页源代码 ③通过网页源代码提取我们想要提取的目的数据 ④将数据格式转换为我们需要的数据。

这是示意图,希望大家理解

在了解了基本流程之后,我将通过一个案例来具体实现如何提取我们需要的数据。数据抽取可以使用正则表达式抽取,也可以使用httpclient+jsoup抽取。在此,httpclient+jsou 提取暂不解释。网页数据的做法以后会在httpclient+jsoup上具体讲解。在这里,我们将首先说明如何使用正则表达式提取数据。

我在这里找到了一个网站:我们要提取里面的数据。我们要提取的最终结果是产品型号、数量、报价和供应商。首先我们看到这个网站整页预览

接下来我们看一下网页的源码结构:

上面的源码可以清晰的看到整个网页的源码结构。接下来,我们将提取整个网页的数据。

import java.io.BufferedReader;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class HTMLPageParser {

public static void main(String[] args) throws Exception {

//目的网页URL地址

getURLInfo("http://www.ic.net.cn/userSite/ ... ot%3B,"utf-8");

}

public static List getURLInfo(String urlInfo,String charset) throws Exception {

//读取目的网页URL地址,获取网页源码

URL url = new URL(urlInfo);

HttpURLConnection httpUrl = (HttpURLConnection)url.openConnection();

InputStream is = httpUrl.getInputStream();

BufferedReader br = new BufferedReader(new InputStreamReader(is,"utf-8"));

StringBuilder sb = new StringBuilder();

String line;

while ((line = br.readLine()) != null) {

//这里是对链接进行处理

line = line.replaceAll("]*>", "");

//这里是对样式进行处理

line = line.replaceAll("]*>", "");

sb.append(line);

}

is.close();

br.close();

//获得网页源码

return getDataStructure(sb.toString().trim());

}

static Pattern proInfo

= Pattern.compile("(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)", Pattern.DOTALL);

private static List getDataStructure(String str) {

//运用正则表达式对获取的网页源码进行数据匹配,提取我们所要的数据,在以后的过程中,我们可以采用httpclient+jsoup,

//现在暂时运用正则表达式对数据进行抽取提取

String[] info = str.split("");

List list = new ArrayList();

for (String s : info) {

Matcher m = proInfo.matcher(s);

Product p = null;

if (m.find()) {

p = new Product();

//设置产品型号

String[] ss = m.group(1).trim().replace(" ", "").split(">");

p.setProStyle(ss[1]);

//设置产品数量

p.setProAmount(m.group(2).trim().replace(" ", ""));

//设置产品报价

p.setProPrice(m.group(4).trim().replace(" ", ""));

//设置产品供应商

p.setProSupplier(m.group(5).trim().replace(" ", ""));

list.add(p);

}

}

//这里对集合里面不是我们要提取的数据进行移除

list.remove(0);

for (int i = 0; i < list.size(); i++) {

System.out.println("产品型号:"+list.get(i).getProStyle()+",产品数量:"+list.get(i).getProAmount()

+",产品报价:"+list.get(i).getProPrice()+",产品供应商:"+list.get(i).getProSupplier());

}

return list;

}

}

class Product {

private String proStyle;//产品型号

private String proAmount;//产品数量

private String proPrice;//产品报价

private String proSupplier;//产品供应商

public String getProStyle() {

return proStyle;

}

public void setProStyle(String proStyle) {

this.proStyle = proStyle;

}

public String getProSupplier() {

return proSupplier;

}

public void setProSupplier(String proSupplier) {

this.proSupplier = proSupplier;

}

public String getProAmount() {

return proAmount;

}

public void setProAmount(String proAmount) {

this.proAmount = proAmount;

}

public String getProPrice() {

return proPrice;

}

public void setProPrice(String proPrice) {

this.proPrice = proPrice;

}

public Product() {

}

@Override

public String toString() {

return "Product [proAmount=" + proAmount + ", proPrice=" + proPrice

+ ", proStyle=" + proStyle + ", proSupplier=" + proSupplier

+ "]";

}

}

好了,运行上面的程序,我们得到如下数据,也就是我们最终想要得到的数据

成功获取数据,这就是我们想要得到的最终数据结果。最后要说的是,这里的这个网页比较简单,源数据可以在网页的源代码中看到,而这个方法就是在get方法中提交数据。,当真的是采集时,有些网页结构复杂,源码中可能没有我们想要提取的数据。以后我会介绍这点的解决方案。还有,我在这个页面采集的时候,只有采集当前页面的数据,还有分页的数据,这里就不解释了,只是一个提示,大家可以用多线程采集所有页面的当前数据,一个采集当前页面数据和一个翻页动作可以通过线程完成采集所有数据。

我们匹配的数据可能在项目的实际开发中,我们需要将提取的数据存储起来,方便我们接下来的数据查询操作。

网页抓取数据 免费(自动模式检测WebHarvy自动识别允许您在网页中发生的数据模式)

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2021-11-06 22:23

WebHarvy 是一款用户界面简单、操作简单的网页数据抓取工具。它具有自动检测模式。它可以从任何页面中提取数据,包括文本、图片等,输入网址即可打开。默认使用内部浏览器提取数据,可以导出到数据库或文件夹。功能介绍 点击界面 WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!自动模式检测 WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。

可以将任意数量的输入关键字提交到多个输入文本字段以执行搜索。可以提取输入关键字组合的所有搜索结果数据。为了通过代理服务器匿名抓取,防止网络爬虫软件被网络服务器拦截,您可以选择通过代理服务器或VPN网站访问目标。可以使用单个代理服务器地址或代理服务器地址列表。类别提取WebHarvyWebScraper 允许您从链接列表中获取数据,从而在网站 中产生类似的页面/列表。这允许您使用单个配置来抓取 网站 内的类别和子类别。正则表达式 WebHarvy 允许您在网页的文本或 HTML 源代码上应用正则表达式 (RegEx) 并删除匹配的部分。这种强大的技术为您在抓取数据时提供了更大的灵活性。运行 JavaScript 在提取数据之前在浏览器中运行您自己的 JavaScript 代码。这可用于与页面元素交互或调用已在目标页面中实现的 JavaScript 函数。下载图片可以下载图片或提取图片网址。WebHarvy 可以自动提取显示在电子商务网站的商品详情页面中的多张图片。自动浏览器交互 WebHarvy 可以轻松配置为执行任务,例如单击链接、选择列表/下拉选项、在字段中输入文本、滚动页面等。更新日志修复了连接可能在以下情况下被禁用的问题页面启动。您可以为寻呼模式配置专用的连接方式。可以自动搜索可以在 HTML 上配置的资源。增加了在键盘上向下滚动下一页的功能。添加了通过 Java 脚本加载下一页。增加了URL配置功能。您可以在列表中输入关键字进行 2 次搜索。 查看全部

网页抓取数据 免费(自动模式检测WebHarvy自动识别允许您在网页中发生的数据模式)

WebHarvy 是一款用户界面简单、操作简单的网页数据抓取工具。它具有自动检测模式。它可以从任何页面中提取数据,包括文本、图片等,输入网址即可打开。默认使用内部浏览器提取数据,可以导出到数据库或文件夹。功能介绍 点击界面 WebHarvy 是一个可视化的网络爬虫。绝对不需要编写任何脚本或代码来抓取数据。您将使用 WebHarvy 的内置浏览器来浏览网络。您可以选择要单击的数据。这很简单!自动模式检测 WebHarvy 自动识别网页中出现的数据模式。因此,如果您需要从网页中抓取项目列表(姓名、地址、电子邮件、价格等),则无需执行任何其他配置。如果数据重复,WebHarvy 会自动删除它。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。导出捕获的数据 您可以以多种格式保存从网页中提取的数据。当前版本的 WebHarvyWebScraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文件。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。您还可以将捕获的数据导出到 SQL 数据库。从多个页面中提取数据 通常,网页会在多个页面上显示产品列表等数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需指出“链接到下一页”,WebHarvyWebScraper 就会自动从所有页面中抓取数据。基于关键字的抓取通过在搜索表单中自动提交输入关键字列表来捕获数据。

可以将任意数量的输入关键字提交到多个输入文本字段以执行搜索。可以提取输入关键字组合的所有搜索结果数据。为了通过代理服务器匿名抓取,防止网络爬虫软件被网络服务器拦截,您可以选择通过代理服务器或VPN网站访问目标。可以使用单个代理服务器地址或代理服务器地址列表。类别提取WebHarvyWebScraper 允许您从链接列表中获取数据,从而在网站 中产生类似的页面/列表。这允许您使用单个配置来抓取 网站 内的类别和子类别。正则表达式 WebHarvy 允许您在网页的文本或 HTML 源代码上应用正则表达式 (RegEx) 并删除匹配的部分。这种强大的技术为您在抓取数据时提供了更大的灵活性。运行 JavaScript 在提取数据之前在浏览器中运行您自己的 JavaScript 代码。这可用于与页面元素交互或调用已在目标页面中实现的 JavaScript 函数。下载图片可以下载图片或提取图片网址。WebHarvy 可以自动提取显示在电子商务网站的商品详情页面中的多张图片。自动浏览器交互 WebHarvy 可以轻松配置为执行任务,例如单击链接、选择列表/下拉选项、在字段中输入文本、滚动页面等。更新日志修复了连接可能在以下情况下被禁用的问题页面启动。您可以为寻呼模式配置专用的连接方式。可以自动搜索可以在 HTML 上配置的资源。增加了在键盘上向下滚动下一页的功能。添加了通过 Java 脚本加载下一页。增加了URL配置功能。您可以在列表中输入关键字进行 2 次搜索。

网页抓取数据 免费( 从电子商务店铺大规模提取产品数据时所学到的经验教训挑战)

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2021-11-06 14:14

从电子商务店铺大规模提取产品数据时所学到的经验教训挑战)

现在从互联网上获取数据似乎很容易。有很多开源的库和框架,可视化爬虫工具和数据提取工具,可以很方便的从一个网站中抓取数据。然而,当你想大规模搜索网站时,很快就变得非常棘手。

在本文中,我们将与您分享自 2010 年以来在 Scrapinghub 的帮助下从 1000 亿产品页面中抓取数据的经验教训,并让您深入了解从电子商务商店中提取产品数据时所面临的挑战。大规模。,并与您分享一些应对这些挑战的最佳实践。

Scrapinghub 成立于 2010 年,是最好的数据提取公司之一,Scrapy-Scrapy 的创建者是当今最强大和最受欢迎的网络抓取框架。目前,Scrapinghub 每月为全球许多大型电子商务公司抓取超过 80 亿个页面(其中 30 亿个是产品页面)。

大规模网络爬虫的要点

不同于标准的网络爬虫应用,电子商务产品数据的大规模爬取将面临一系列独特的挑战,这使得网络爬行变得异常困难。

本质上,这些困难可以归结为两个方面:速度和数据质量。

通常时间是一个限制性的约束,所以大规模的抓取需要网络爬虫以非常高的速度抓取页面,并且不会影响数据质量。这种对速度的要求使得捕获大量产品数据变得非常具有挑战性。

挑战一:乱七八糟的网页格式

凌乱多变的网页格式可能是最常见的挑战,也可能不是最有趣的挑战,但却是迄今为止大规模数据提取面临的最大挑战。这个挑战的关键不是复杂性,而是需要大量的时间和资源来应对。

如果你有过电商店铺爬虫体验,就会知道电商店铺代码杂乱无章是普遍现象。这不仅仅是 HTML 格式或偶尔字符编码的问题。多年来,我们遇到了各种各样的问题,比如滥用 HTTP 响应代码、不完整的 JavaScript 或滥用 Ajax:

这样乱七八糟的代码会让编写爬虫非常痛苦,无法使用爬虫工具或自动提取工具。

在大规模抓取网页时,你不仅需要像这样浏览数百个乱七八糟的网站,还要处理网站的不断更新。一个经验法则是:每 2-3 个月目标 网站 的变化就会废除你的爬虫。

听起来可能没什么大不了的,但是当你大规模地爬行时,这些事故就会累积起来。比如Scrapinghub的一个大型电商项目,爬虫大约有4000个,需要爬取1000个电商网站,这意味着他们每天有20-30个爬虫失败。

从区域和多语言网站布局变化来看,A/B拆分测试和打包/定价变化往往会给爬虫带来问题。

没有捷径

不幸的是,这些问题没有灵丹妙药。在很多情况下,我们只能随着规模的扩大投入更多的资源。以上述项目为例,负责该项目的团队共有18名爬虫工程师和3名专职QA,以确保客户始终拥有可靠的数据。

然而,有了经验,团队可以学习如何创建更强大的爬虫来检测和处理 网站 格式的各种奇怪的技巧。

最佳实践不是针对目标网站的所有可能的布局都一一编写爬虫,而是从一个产品中提取的爬虫可以处理不同页面布局所使用的所有可能的规则和方案。爬虫的配置越多越好。

虽然这些做法会使爬虫变得更加复杂(我们的一些爬虫有几千行长),但它们可以确保爬虫更容易维护。

由于大多数公司每天都需要提取产品数据,我们不能花几天时间等待工程团队修改损坏的爬虫。对于这种情况,Scrapinghub 使用基于数据提取工具的机器学习。我们开发了这个机器学习模型作为备份,直到爬虫被修复。这个基于机器学习的提取工具可以自动识别目标网站的目标字段(产品名称、价格、货币、图片、SKU等),并返回想要的结果。

挑战 2:可扩展架构

您将面临的下一个挑战是构建一个爬虫基础设施,该基础设施可以随着每天请求数量的增加而扩展,而不会降低性能。

在大规模提取产品数据时,简单的网络爬虫只能连续爬取数据,不能提取。通常,连续的网络爬虫会一个接一个地循环发送请求,每个请求需要 2-3 秒才能完成。

如果爬虫每天少于40000个请求(每2秒发送一个请求,意味着每天可以发送43200个请求),这种方法是可以的。但是,一旦请求数量超过这个数量,就需要切换到每天可以发送数百万个请求而不降低性能的爬虫架构。

如上所述,速度是大规模捕获产品数据的关键。您需要确保在特定时间段(通常为一天)内找到并抓取所有需要的产品页面。为此,您需要执行以下操作:

将产品搜索与产品提取分开

为了大规模提取产品数据,您需要将产品搜索爬虫与产品提取爬虫分开。

产品搜索爬虫的目标应该是找到目标产品类别(或“货架”),并将产品的 URL 保存在该类别下,以供产品提取爬虫使用。当产品搜索爬虫将产品 URL 添加到队列中时,产品提取爬虫会从茶叶页面抓取目标数据。

这项工作可以借助流行的爬虫工具,例如Scrapinghub 开发的开源爬虫工具Frontera。虽然 Frontera 最初是为在 Scrapy 中使用而设计的,但它是完全不受限制的,可以与任何其他爬虫框架或独立项目一起使用。在本文中,我们将分享如何使用 Frontera 从 HackerNews 中挖掘数据。

为产品提取分配更多资源

由于每个产品类别“货架”可以收录10到100个产品,并且与提取产品URL相比,提取产品数据需要更多资源,因此搜索爬虫通常比产品提取爬虫更快。在这种情况下,您需要为每个搜索爬虫配备多个提取爬虫。经验法则是:每 100,000 个页面需要创建一个单独的提取爬虫。

挑战 3:保持吞吐量性能

大规模抢车很像一级方程式,我们的目标是提高速度,尽可能减轻车重,从发动机榨出最后一部分马力。大规模的网络爬虫也是如此。

在提取大量数据时,我们必须在现有硬件资源的基础上,尽可能地找到一种可以最小化循环时间并最大化爬虫性能的方法。所有这些都必须减少每个请求的时间,甚至几毫秒。

为此,您的团队需要深入了解网络抓取框架、代理管理和正在使用的硬件,以便更好地调整它们以获得最佳性能。您还需要注意:

履带效率

在大规模抓取时,我们应该始终努力在最少的请求中提取所需的确切数据。任何额外的请求或数据提取都会降低爬取网站的速度。在设计爬虫时,请记住以下几点:

挑战四:反机器人策略

在大规模爬取电商网站时,你肯定会遇到使用反机器人策略的网站。

对于大多数小网站来说,他们的反机器人策略是非常基础的(IP禁止过度请求)。但是对于亚马逊网站这样的大型电商公司,他们会使用非常成熟的反机器人策略,比如Distil Networks、Incapsula或者Akamai,这会让数据提取变得更加困难。

演戏

请记住,大型产品数据抓取项目最重要的要求是使用代理IP。在大规模爬取中,需要一个相当大的代理列表,并且需要实现必要的IP轮换、请求限制、会话管理、黑名单逻辑,防止代理被阻塞。

除非您拥有庞大的管理代理团队,否则您应该将这部分爬行工作外包。外面有大量的代理服务,可以提供各种级别的服务。

但是,我们建议您使用代理为代理配置提供单一端点并隐藏管理代理的复杂性。大规模爬取是非常耗费资源的,更不用说需要通过开发和维护建立自己内部的代理管理基础设施。

大多数大型电子商务公司都使用这种方法。许多世界上最大的电子商务公司都使用 Scrapinghub 开发的智能下载器 Crawlera 来外包代理管理。如果您的爬虫每天需要发出 2000 万个请求,那么专注于捕获比代理管理更有意义。

超越代理

不幸的是,仅使用代理服务还不足以确保可以绕过大型电子商务网站的反僵尸策略。越来越多的网站开始使用成熟的反机器人策略来监控爬虫行为并检测请求是否来自人类访问者。

这些反机器人策略不仅会使电商网站的爬虫变得困难,如果处理不当,与它们的斗争也会严重影响爬虫的性能。

这些反机器人策略大多使用 JavaScript 来确定请求是来自爬虫还是来自人类(JavaScript 引擎检查、字体枚举、WebGL、Canvas 等)。

但是前面提到,在大规模抓取数据时,我们希望使用无头的脚本化浏览器(如Splash或Puppeteer等)。页面上的 JavaScript 渲染会给资源带来压力,减少爬取。网站 速度。

这意味着,为了保证你的爬虫能够达到必要的吞吐量并提供日常的产品数据,你通常需要努力反击网站上使用的机器人策略,并将爬虫设计成使用无头它们可以在某些浏览器的情况下也会被打败。

挑战 5:数据质量

从数据科学家的角度来看,网络抓取项目最重要的考虑因素是提取数据的质量。大规模爬取更注重数据的质量。

如果每天需要提取数百万个数据点,则无法手动验证所有数据是否干净完整。小心脏数据或不完整的数据会进入数据源,破坏数据分析工作。

当商店有多个版本(不同语言、不同地区等)或从不同商店抓取数据时,数据质量尤为重要。

除了仔细的QA流程,在创建爬虫的设计阶段,相互审查和测试爬虫代码可以确保以最可靠的方式提取所需的数据。确保高数据质量的最佳方法是开发自动化 QA 监控系统。

作为数据提取项目的一部分,您需要规划和开发一个监控系统,以提醒您数据不一致和抓取错误。在 Scrapinghub,我们开发了用于检测的机器学习算法:

总结

如您所见,大规模抓取产品数据需要一系列独特的挑战。希望这个 文章 可以让您更好地了解这些挑战以及如何解决它们。

在 Scrapinghub,我们专注于将非结构化 Web 数据转换为结构化数据。如果您对本文有任何想法,请在下面发表评论。

原来的: 查看全部

网页抓取数据 免费(

从电子商务店铺大规模提取产品数据时所学到的经验教训挑战)

现在从互联网上获取数据似乎很容易。有很多开源的库和框架,可视化爬虫工具和数据提取工具,可以很方便的从一个网站中抓取数据。然而,当你想大规模搜索网站时,很快就变得非常棘手。

在本文中,我们将与您分享自 2010 年以来在 Scrapinghub 的帮助下从 1000 亿产品页面中抓取数据的经验教训,并让您深入了解从电子商务商店中提取产品数据时所面临的挑战。大规模。,并与您分享一些应对这些挑战的最佳实践。

Scrapinghub 成立于 2010 年,是最好的数据提取公司之一,Scrapy-Scrapy 的创建者是当今最强大和最受欢迎的网络抓取框架。目前,Scrapinghub 每月为全球许多大型电子商务公司抓取超过 80 亿个页面(其中 30 亿个是产品页面)。

大规模网络爬虫的要点

不同于标准的网络爬虫应用,电子商务产品数据的大规模爬取将面临一系列独特的挑战,这使得网络爬行变得异常困难。

本质上,这些困难可以归结为两个方面:速度和数据质量。

通常时间是一个限制性的约束,所以大规模的抓取需要网络爬虫以非常高的速度抓取页面,并且不会影响数据质量。这种对速度的要求使得捕获大量产品数据变得非常具有挑战性。

挑战一:乱七八糟的网页格式

凌乱多变的网页格式可能是最常见的挑战,也可能不是最有趣的挑战,但却是迄今为止大规模数据提取面临的最大挑战。这个挑战的关键不是复杂性,而是需要大量的时间和资源来应对。

如果你有过电商店铺爬虫体验,就会知道电商店铺代码杂乱无章是普遍现象。这不仅仅是 HTML 格式或偶尔字符编码的问题。多年来,我们遇到了各种各样的问题,比如滥用 HTTP 响应代码、不完整的 JavaScript 或滥用 Ajax:

这样乱七八糟的代码会让编写爬虫非常痛苦,无法使用爬虫工具或自动提取工具。

在大规模抓取网页时,你不仅需要像这样浏览数百个乱七八糟的网站,还要处理网站的不断更新。一个经验法则是:每 2-3 个月目标 网站 的变化就会废除你的爬虫。

听起来可能没什么大不了的,但是当你大规模地爬行时,这些事故就会累积起来。比如Scrapinghub的一个大型电商项目,爬虫大约有4000个,需要爬取1000个电商网站,这意味着他们每天有20-30个爬虫失败。

从区域和多语言网站布局变化来看,A/B拆分测试和打包/定价变化往往会给爬虫带来问题。

没有捷径

不幸的是,这些问题没有灵丹妙药。在很多情况下,我们只能随着规模的扩大投入更多的资源。以上述项目为例,负责该项目的团队共有18名爬虫工程师和3名专职QA,以确保客户始终拥有可靠的数据。

然而,有了经验,团队可以学习如何创建更强大的爬虫来检测和处理 网站 格式的各种奇怪的技巧。

最佳实践不是针对目标网站的所有可能的布局都一一编写爬虫,而是从一个产品中提取的爬虫可以处理不同页面布局所使用的所有可能的规则和方案。爬虫的配置越多越好。

虽然这些做法会使爬虫变得更加复杂(我们的一些爬虫有几千行长),但它们可以确保爬虫更容易维护。

由于大多数公司每天都需要提取产品数据,我们不能花几天时间等待工程团队修改损坏的爬虫。对于这种情况,Scrapinghub 使用基于数据提取工具的机器学习。我们开发了这个机器学习模型作为备份,直到爬虫被修复。这个基于机器学习的提取工具可以自动识别目标网站的目标字段(产品名称、价格、货币、图片、SKU等),并返回想要的结果。

挑战 2:可扩展架构

您将面临的下一个挑战是构建一个爬虫基础设施,该基础设施可以随着每天请求数量的增加而扩展,而不会降低性能。

在大规模提取产品数据时,简单的网络爬虫只能连续爬取数据,不能提取。通常,连续的网络爬虫会一个接一个地循环发送请求,每个请求需要 2-3 秒才能完成。

如果爬虫每天少于40000个请求(每2秒发送一个请求,意味着每天可以发送43200个请求),这种方法是可以的。但是,一旦请求数量超过这个数量,就需要切换到每天可以发送数百万个请求而不降低性能的爬虫架构。

如上所述,速度是大规模捕获产品数据的关键。您需要确保在特定时间段(通常为一天)内找到并抓取所有需要的产品页面。为此,您需要执行以下操作:

将产品搜索与产品提取分开

为了大规模提取产品数据,您需要将产品搜索爬虫与产品提取爬虫分开。

产品搜索爬虫的目标应该是找到目标产品类别(或“货架”),并将产品的 URL 保存在该类别下,以供产品提取爬虫使用。当产品搜索爬虫将产品 URL 添加到队列中时,产品提取爬虫会从茶叶页面抓取目标数据。

这项工作可以借助流行的爬虫工具,例如Scrapinghub 开发的开源爬虫工具Frontera。虽然 Frontera 最初是为在 Scrapy 中使用而设计的,但它是完全不受限制的,可以与任何其他爬虫框架或独立项目一起使用。在本文中,我们将分享如何使用 Frontera 从 HackerNews 中挖掘数据。

为产品提取分配更多资源

由于每个产品类别“货架”可以收录10到100个产品,并且与提取产品URL相比,提取产品数据需要更多资源,因此搜索爬虫通常比产品提取爬虫更快。在这种情况下,您需要为每个搜索爬虫配备多个提取爬虫。经验法则是:每 100,000 个页面需要创建一个单独的提取爬虫。

挑战 3:保持吞吐量性能

大规模抢车很像一级方程式,我们的目标是提高速度,尽可能减轻车重,从发动机榨出最后一部分马力。大规模的网络爬虫也是如此。

在提取大量数据时,我们必须在现有硬件资源的基础上,尽可能地找到一种可以最小化循环时间并最大化爬虫性能的方法。所有这些都必须减少每个请求的时间,甚至几毫秒。

为此,您的团队需要深入了解网络抓取框架、代理管理和正在使用的硬件,以便更好地调整它们以获得最佳性能。您还需要注意:

履带效率

在大规模抓取时,我们应该始终努力在最少的请求中提取所需的确切数据。任何额外的请求或数据提取都会降低爬取网站的速度。在设计爬虫时,请记住以下几点:

挑战四:反机器人策略

在大规模爬取电商网站时,你肯定会遇到使用反机器人策略的网站。

对于大多数小网站来说,他们的反机器人策略是非常基础的(IP禁止过度请求)。但是对于亚马逊网站这样的大型电商公司,他们会使用非常成熟的反机器人策略,比如Distil Networks、Incapsula或者Akamai,这会让数据提取变得更加困难。

演戏

请记住,大型产品数据抓取项目最重要的要求是使用代理IP。在大规模爬取中,需要一个相当大的代理列表,并且需要实现必要的IP轮换、请求限制、会话管理、黑名单逻辑,防止代理被阻塞。

除非您拥有庞大的管理代理团队,否则您应该将这部分爬行工作外包。外面有大量的代理服务,可以提供各种级别的服务。

但是,我们建议您使用代理为代理配置提供单一端点并隐藏管理代理的复杂性。大规模爬取是非常耗费资源的,更不用说需要通过开发和维护建立自己内部的代理管理基础设施。

大多数大型电子商务公司都使用这种方法。许多世界上最大的电子商务公司都使用 Scrapinghub 开发的智能下载器 Crawlera 来外包代理管理。如果您的爬虫每天需要发出 2000 万个请求,那么专注于捕获比代理管理更有意义。

超越代理

不幸的是,仅使用代理服务还不足以确保可以绕过大型电子商务网站的反僵尸策略。越来越多的网站开始使用成熟的反机器人策略来监控爬虫行为并检测请求是否来自人类访问者。

这些反机器人策略不仅会使电商网站的爬虫变得困难,如果处理不当,与它们的斗争也会严重影响爬虫的性能。

这些反机器人策略大多使用 JavaScript 来确定请求是来自爬虫还是来自人类(JavaScript 引擎检查、字体枚举、WebGL、Canvas 等)。

但是前面提到,在大规模抓取数据时,我们希望使用无头的脚本化浏览器(如Splash或Puppeteer等)。页面上的 JavaScript 渲染会给资源带来压力,减少爬取。网站 速度。

这意味着,为了保证你的爬虫能够达到必要的吞吐量并提供日常的产品数据,你通常需要努力反击网站上使用的机器人策略,并将爬虫设计成使用无头它们可以在某些浏览器的情况下也会被打败。

挑战 5:数据质量

从数据科学家的角度来看,网络抓取项目最重要的考虑因素是提取数据的质量。大规模爬取更注重数据的质量。

如果每天需要提取数百万个数据点,则无法手动验证所有数据是否干净完整。小心脏数据或不完整的数据会进入数据源,破坏数据分析工作。

当商店有多个版本(不同语言、不同地区等)或从不同商店抓取数据时,数据质量尤为重要。

除了仔细的QA流程,在创建爬虫的设计阶段,相互审查和测试爬虫代码可以确保以最可靠的方式提取所需的数据。确保高数据质量的最佳方法是开发自动化 QA 监控系统。

作为数据提取项目的一部分,您需要规划和开发一个监控系统,以提醒您数据不一致和抓取错误。在 Scrapinghub,我们开发了用于检测的机器学习算法:

总结

如您所见,大规模抓取产品数据需要一系列独特的挑战。希望这个 文章 可以让您更好地了解这些挑战以及如何解决它们。

在 Scrapinghub,我们专注于将非结构化 Web 数据转换为结构化数据。如果您对本文有任何想法,请在下面发表评论。

原来的:

网页抓取数据 免费(python基于python分布式多爬虫共享队列主题爬虫(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-11-06 14:11

阿里云>云栖社区>主题图>P>Crawler抓取网页指定数据库

推荐活动:

更多优惠>

当前主题:爬虫爬取网页指定数据库添加到采集夹

相关话题:

爬虫爬取网页指定数据库相关的博客。查看更多博客

云数据库产品概述

作者:阿里云官网

云数据库是稳定、可靠、可弹性扩展的在线数据库服务产品的总称。可轻松运维全球90%以上主流开源和商业数据库(MySQL、SQL Server、Redis等),同时为POLARDB提供6倍以上的开源数据库性能和开源数据库的价格,以及自主研发的具有100TB数据实时计算能力的HybridDB,对于数据库,也有容灾、备份、恢复、监控、迁移的一整套解决方案。

现在查看

Scrapy分布式、去重增量爬虫的开发设计

作者:技术小能手8758人浏览评论:03年前

基于python的分布式房屋数据采集系统为数据的进一步应用提供数据支持,即房屋推荐系统。本课题致力于解决单进程单机爬虫的瓶颈,打造基于Redis分布式多爬虫共享队列的主题爬虫。本系统使用python开发的Scrapy框架开发,使用Xpath

阅读全文

使用Python爬虫抓取免费代理IP

作者:小技术专家 2872人浏览评论:03年前

不知道大家有没有遇到过“访问频率太高”之类的网站提示。我们需要等待一段时间或输入验证码才能解锁,但此后仍会出现这种情况。出现这种现象的原因是我们要爬取的网页采取了反爬虫措施。比如某个ip单位时间请求一个网页的次数过多,服务器就会拒绝服务。在这种情况下,

阅读全文

爬虫和 urllib 库概述(一)

作者:蓝の流星VIP1588人浏览评论:03年前

1 爬虫概述(1)互联网爬虫是一种根据Url抓取网页以获取有用信息的程序(2)抓取网页解析数据的核心任务。难点:爬虫与反的博弈-crawlers(3)爬虫语言PHP多进程多线程支持不好。Java目前对Java爬虫需求旺盛,但代码臃肿,重构成本高。

阅读全文

如何使用 Python 抓取数据?(一)网页抓取

作者:王淑仪 2089人浏览评论:03年前

您期待已久的 Python 网络数据爬虫教程就在这里。本文将向您展示如何从网页中查找有趣的链接和解释性文本,将它们抓取并存储在 Excel 中。我需要在公众号后台,经常能收到读者的消息。很多评论都是来自读者的提问。只要我有时间,我会花时间尝试和回答。但有些评论乍一看不清楚

阅读全文

一个小型网络爬虫系统的架构设计

作者:技术组合 902人浏览评论:03年前

一个小型网络爬虫系统的架构设计。网络爬虫服务是互联网上经常使用的服务。在搜索引擎中,蜘蛛(网络爬虫)是必不可少的核心服务。搜索引擎衡量的四个指标“多、快、准、新”中,多、快、新都是对蜘蛛的要求。google、baidu等搜索引擎公司维护

阅读全文

【网络爬虫】使用node.jscheerio爬取网页数据

作者:自娱自乐 5358人浏览评论:05年前

您是想自动从网页中抓取一些数据,还是想将从某个博客中提取的一堆数据转换为结构化数据?有没有现成的API来获取数据?!!!!@#$@#$... 可以解决网页爬虫就好了。什么是网络爬虫?你可能会问。. . 网络爬虫是以编程方式(通常无需浏览器参与)检索网页内容。

阅读全文

爬取网页数据分析

作者:y0umer606 浏览评论人数:010年前

发表于 2006-05-24 14:04 北极燕鸥阅读(9793) 评论(42) 编辑采集类别:C#编程自动阅读其他网站网页显示信息类似于a爬虫程序,比如我们有一个系统提取百度网站歌曲搜索排名分析系统

阅读全文

抓取网页数据分析(c#)

作者:wenvi_wu1489 浏览评论人数:012年前

其他网站网页上显示的信息是通过程序自动读取的,类似于爬虫程序。比如我们有一个系统来提取百度网站歌曲搜索排名。分析系统根据获得的数据进行数据分析。为企业提供参考数据。为了完成上述需求,我们需要模拟浏览器浏览网页,并获取页面的数据进行分析。

阅读全文 查看全部

网页抓取数据 免费(python基于python分布式多爬虫共享队列主题爬虫(组图))

阿里云>云栖社区>主题图>P>Crawler抓取网页指定数据库

推荐活动:

更多优惠>

当前主题:爬虫爬取网页指定数据库添加到采集夹

相关话题:

爬虫爬取网页指定数据库相关的博客。查看更多博客

云数据库产品概述

作者:阿里云官网

云数据库是稳定、可靠、可弹性扩展的在线数据库服务产品的总称。可轻松运维全球90%以上主流开源和商业数据库(MySQL、SQL Server、Redis等),同时为POLARDB提供6倍以上的开源数据库性能和开源数据库的价格,以及自主研发的具有100TB数据实时计算能力的HybridDB,对于数据库,也有容灾、备份、恢复、监控、迁移的一整套解决方案。

现在查看

Scrapy分布式、去重增量爬虫的开发设计

作者:技术小能手8758人浏览评论:03年前

基于python的分布式房屋数据采集系统为数据的进一步应用提供数据支持,即房屋推荐系统。本课题致力于解决单进程单机爬虫的瓶颈,打造基于Redis分布式多爬虫共享队列的主题爬虫。本系统使用python开发的Scrapy框架开发,使用Xpath

阅读全文

使用Python爬虫抓取免费代理IP

作者:小技术专家 2872人浏览评论:03年前

不知道大家有没有遇到过“访问频率太高”之类的网站提示。我们需要等待一段时间或输入验证码才能解锁,但此后仍会出现这种情况。出现这种现象的原因是我们要爬取的网页采取了反爬虫措施。比如某个ip单位时间请求一个网页的次数过多,服务器就会拒绝服务。在这种情况下,

阅读全文

爬虫和 urllib 库概述(一)

作者:蓝の流星VIP1588人浏览评论:03年前

1 爬虫概述(1)互联网爬虫是一种根据Url抓取网页以获取有用信息的程序(2)抓取网页解析数据的核心任务。难点:爬虫与反的博弈-crawlers(3)爬虫语言PHP多进程多线程支持不好。Java目前对Java爬虫需求旺盛,但代码臃肿,重构成本高。

阅读全文

如何使用 Python 抓取数据?(一)网页抓取

作者:王淑仪 2089人浏览评论:03年前

您期待已久的 Python 网络数据爬虫教程就在这里。本文将向您展示如何从网页中查找有趣的链接和解释性文本,将它们抓取并存储在 Excel 中。我需要在公众号后台,经常能收到读者的消息。很多评论都是来自读者的提问。只要我有时间,我会花时间尝试和回答。但有些评论乍一看不清楚

阅读全文

一个小型网络爬虫系统的架构设计

作者:技术组合 902人浏览评论:03年前

一个小型网络爬虫系统的架构设计。网络爬虫服务是互联网上经常使用的服务。在搜索引擎中,蜘蛛(网络爬虫)是必不可少的核心服务。搜索引擎衡量的四个指标“多、快、准、新”中,多、快、新都是对蜘蛛的要求。google、baidu等搜索引擎公司维护

阅读全文

【网络爬虫】使用node.jscheerio爬取网页数据

作者:自娱自乐 5358人浏览评论:05年前

您是想自动从网页中抓取一些数据,还是想将从某个博客中提取的一堆数据转换为结构化数据?有没有现成的API来获取数据?!!!!@#$@#$... 可以解决网页爬虫就好了。什么是网络爬虫?你可能会问。. . 网络爬虫是以编程方式(通常无需浏览器参与)检索网页内容。

阅读全文

爬取网页数据分析

作者:y0umer606 浏览评论人数:010年前

发表于 2006-05-24 14:04 北极燕鸥阅读(9793) 评论(42) 编辑采集类别:C#编程自动阅读其他网站网页显示信息类似于a爬虫程序,比如我们有一个系统提取百度网站歌曲搜索排名分析系统

阅读全文

抓取网页数据分析(c#)

作者:wenvi_wu1489 浏览评论人数:012年前

其他网站网页上显示的信息是通过程序自动读取的,类似于爬虫程序。比如我们有一个系统来提取百度网站歌曲搜索排名。分析系统根据获得的数据进行数据分析。为企业提供参考数据。为了完成上述需求,我们需要模拟浏览器浏览网页,并获取页面的数据进行分析。

阅读全文

网页抓取数据 免费(Python开发的一个快速,高层次高层次(图)人)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-11-06 14:09

阿里云>云栖社区>主题图>C>从网站中抓取数据库

推荐活动:

更多优惠>

当前主题:从 网站 抓取数据库并将其添加到采集夹

相关话题:

从网站抓取数据库相关博客,查看更多博客

云数据库产品概述

作者:阿里云官网

云数据库是稳定、可靠、可弹性扩展的在线数据库服务产品的总称。可轻松运维全球90%以上主流开源和商业数据库(MySQL、SQL Server、Redis等),同时为POLARDB提供6倍以上的开源数据库性能和开源数据库的价格,以及自主研发的具有100TB数据实时计算能力的HybridDB,对于数据库,也有容灾、备份、恢复、监控、迁移的一整套解决方案。

现在查看

使用 Scrapy 抓取数据

作者:雨客6542人浏览评论:05年前

Scrapy 是一个由 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站和从页面中提取结构化数据。Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。官方主页:中文文档:Scrap

阅读全文

为什么选择 Prometheus 作为时间序列数据库

作者:耳东@Erdong6491 浏览评论人数:02年前

Prometheus 和 Graphite 系列 Graphite 专注于成为具有查询语言和图形功能的被动时间序列数据库。任何其他问题都由外部组件处理。Prometheus 是一个完整的监控和趋势系统,包括内置和主动的爬取、存储、查询、绘图和基于时间的

阅读全文

在选择数据库的路上,我们遇到了哪些坑?(2)

作者:oneapm_official1769 人浏览评论:05年前

【编者按】您会如何选择数据库、关系数据库、XML 数据库、资源描述框架(RDF)或图形数据库?本文的第 1 部分深入而生动地探讨了各种选项。在第二部分,我们将深入介绍使用 Neo4j 时的注意点。文章是国内ITOM管理平台OneAPM的编译呈现。过渡到 N

阅读全文

Linux云服务器下配置Scrapy抓取数据

作者:㭍叶1552人浏览评论:04年前

基础设备:Linux云服务器(阿里云Ubuntu 16.04);建立远程连接的软件(此处使用XShell);友情链接:Scrapy入门教程:

阅读全文

善用网络爬虫工具,轻松采集数据

作者:优采云采集器1433人浏览评论:04年前

数据已进入各行各业,并得到广泛应用。伴随应用程序的是数据的获取和准确挖掘。我们可以应用的大部分数据来自内部资源库和外部载体。内部数据已经整合好可以使用,而外部数据需要先获取。外部数据的最大载体是互联网。网络上每天难以统计的增量数据,收录了很多对我们来说很有价值的数据。

阅读全文

从头搭建自己的爬虫代理IP数据库,定期检查IP有效性

作者:tomcat1101 浏览评论人数:02年前

ProxyIPPool 从头开始构建自己的代理IP池;根据代理IP URL抓取新的代理IP;验证历史代理IP源地址的有效性:Why use proxy IP 在爬取过程中,很多网站会取反

阅读全文

SEO建立有效页面数据库:目的、定义、流程、应用

作者:于尔武 1043人浏览评论:03年前

关于SEO运营的概念,简单提一下,一个好的SEO工作需要从“产品的需求形成”到“流量的获取和转化”。文章中有这么一段:SEO运营观(交付价值,实现产品)。SEO操作公式:有效查询覆盖,有效爬取,有效收录显示点击转化“有效”定义目标

阅读全文

安全风险:可通过网络搜索用户数据库

作者:知乎1036人浏览评论:04年前

这篇文章是关于安全风险的:可以通过互联网搜索用户数据库。最近在耶鲁大学和南加州医学发生的数据泄露事件凸显了确保数据库的网络界面不被网络搜索引擎暴露的重要性。最近的两起数据库泄漏事件突出了一个常见但经常被忽视的问题。收录敏感信息的错误配置的数据库很容易受到损害。

阅读全文

提问网站 爬取数据库相关问答

【Javascript学习全家桶】934个javascript热点问题,阿里巴巴100位技术专家答疑解惑

作者:管理贝贝5207人浏览评论:13年前

阿里极客公益活动:也许你选择为一个问题夜战,也许你困惑只求答案,也许你因为一个未知而绞尽脑汁,那么他们来了,阿里巴巴技术专家来云栖为您解答技术问题。他们使用自己手中的技术来帮助用户成长。本次活动邀请数百位阿里巴巴技术

阅读全文 查看全部

网页抓取数据 免费(Python开发的一个快速,高层次高层次(图)人)

阿里云>云栖社区>主题图>C>从网站中抓取数据库

推荐活动:

更多优惠>

当前主题:从 网站 抓取数据库并将其添加到采集夹

相关话题:

从网站抓取数据库相关博客,查看更多博客

云数据库产品概述

作者:阿里云官网

云数据库是稳定、可靠、可弹性扩展的在线数据库服务产品的总称。可轻松运维全球90%以上主流开源和商业数据库(MySQL、SQL Server、Redis等),同时为POLARDB提供6倍以上的开源数据库性能和开源数据库的价格,以及自主研发的具有100TB数据实时计算能力的HybridDB,对于数据库,也有容灾、备份、恢复、监控、迁移的一整套解决方案。

现在查看

使用 Scrapy 抓取数据

作者:雨客6542人浏览评论:05年前

Scrapy 是一个由 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站和从页面中提取结构化数据。Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。官方主页:中文文档:Scrap

阅读全文

为什么选择 Prometheus 作为时间序列数据库

作者:耳东@Erdong6491 浏览评论人数:02年前

Prometheus 和 Graphite 系列 Graphite 专注于成为具有查询语言和图形功能的被动时间序列数据库。任何其他问题都由外部组件处理。Prometheus 是一个完整的监控和趋势系统,包括内置和主动的爬取、存储、查询、绘图和基于时间的

阅读全文

在选择数据库的路上,我们遇到了哪些坑?(2)

作者:oneapm_official1769 人浏览评论:05年前

【编者按】您会如何选择数据库、关系数据库、XML 数据库、资源描述框架(RDF)或图形数据库?本文的第 1 部分深入而生动地探讨了各种选项。在第二部分,我们将深入介绍使用 Neo4j 时的注意点。文章是国内ITOM管理平台OneAPM的编译呈现。过渡到 N

阅读全文

Linux云服务器下配置Scrapy抓取数据

作者:㭍叶1552人浏览评论:04年前

基础设备:Linux云服务器(阿里云Ubuntu 16.04);建立远程连接的软件(此处使用XShell);友情链接:Scrapy入门教程:

阅读全文

善用网络爬虫工具,轻松采集数据

作者:优采云采集器1433人浏览评论:04年前

数据已进入各行各业,并得到广泛应用。伴随应用程序的是数据的获取和准确挖掘。我们可以应用的大部分数据来自内部资源库和外部载体。内部数据已经整合好可以使用,而外部数据需要先获取。外部数据的最大载体是互联网。网络上每天难以统计的增量数据,收录了很多对我们来说很有价值的数据。

阅读全文

从头搭建自己的爬虫代理IP数据库,定期检查IP有效性

作者:tomcat1101 浏览评论人数:02年前

ProxyIPPool 从头开始构建自己的代理IP池;根据代理IP URL抓取新的代理IP;验证历史代理IP源地址的有效性:Why use proxy IP 在爬取过程中,很多网站会取反

阅读全文

SEO建立有效页面数据库:目的、定义、流程、应用

作者:于尔武 1043人浏览评论:03年前

关于SEO运营的概念,简单提一下,一个好的SEO工作需要从“产品的需求形成”到“流量的获取和转化”。文章中有这么一段:SEO运营观(交付价值,实现产品)。SEO操作公式:有效查询覆盖,有效爬取,有效收录显示点击转化“有效”定义目标

阅读全文

安全风险:可通过网络搜索用户数据库

作者:知乎1036人浏览评论:04年前

这篇文章是关于安全风险的:可以通过互联网搜索用户数据库。最近在耶鲁大学和南加州医学发生的数据泄露事件凸显了确保数据库的网络界面不被网络搜索引擎暴露的重要性。最近的两起数据库泄漏事件突出了一个常见但经常被忽视的问题。收录敏感信息的错误配置的数据库很容易受到损害。

阅读全文

提问网站 爬取数据库相关问答

【Javascript学习全家桶】934个javascript热点问题,阿里巴巴100位技术专家答疑解惑

作者:管理贝贝5207人浏览评论:13年前

阿里极客公益活动:也许你选择为一个问题夜战,也许你困惑只求答案,也许你因为一个未知而绞尽脑汁,那么他们来了,阿里巴巴技术专家来云栖为您解答技术问题。他们使用自己手中的技术来帮助用户成长。本次活动邀请数百位阿里巴巴技术

阅读全文

网页抓取数据 免费(智能识别方式WebHarvy自动检索)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-11-06 05:06

WebHarvy 是网页数据爬取的专用工具。该软件可以提取网页中的文字和图片,输入网址即可打开。默认设置为使用电脑内置浏览器,适合扩展分析,可自动获取类似连接列表。程序界面 可视化的实际操作很容易。【功能介绍】智能识别方法WebHarvy自动检索网页中出现的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则不需要做所有额外的准备工作。如果数据重复,WebHarvy 会自动抓取。导出捕获的数据可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy URL 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文档。您还可以抓取数据并将其导出到 SQL 数据库。从多个页面中提取通用网页显示信息数据,例如多个页面中的产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。只强调“连接到下一页”,WebHarvy URL 抓取器会自动从所有页面抓取数据。可视化操作面板WebHarvy是一款用于数据可视化网页提取的专用工具。实际上,没有必要编写所有脚本。或者编码用于提取数据。使用 webharvy 的嵌入式计算机浏览器访问网页。您可以选择通过单击鼠标来提取数据。

这太容易了!根据关键词提取 根据关键词提取,可以抓取百度搜索页面关键词输入的列表数据。您创建的设备将自动重复输入所有输入 关键词 和发现的数据。能够指定一个随机的总输入 关键词 提取分类 WebHarvy URL 抓取器允许您从链接列表中提取数据,从而在 网站 内生成类似的页面。这使您能够在抓取的 URL 中应用单一类型或副标题。使用正则表达式提取 WebHarvy 可以在文本或网页的 HTML 源代码中使用正则表达式(正则表达式),并提取匹配的一部分。这种技术性很强,说明你协调能力很强,数据也很顶尖。[软件特点] WebHarvy 是一款视觉效果的网络爬虫。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。非常容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。非常容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。

您还可以将抓取到的数据导出到 SQL 数据库。通常,网页在多个页面上显示诸如信息产品列表之类的数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需强调“连接到下一页”,WebHarvy Web Scraper 就会自动从所有页面抓取数据。【版本更新】恢复页面启动时可以禁止使用链接。可以为page方法配备专用的接口方法。它可以自动检索可以在 HTML 上提供的资源。改进电脑键盘向下翻页功能改进基于Java脚本制作的下一页加载。添加URL设备后,可以在列表2搜索中输入关键词 查看全部

网页抓取数据 免费(智能识别方式WebHarvy自动检索)

WebHarvy 是网页数据爬取的专用工具。该软件可以提取网页中的文字和图片,输入网址即可打开。默认设置为使用电脑内置浏览器,适合扩展分析,可自动获取类似连接列表。程序界面 可视化的实际操作很容易。【功能介绍】智能识别方法WebHarvy自动检索网页中出现的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则不需要做所有额外的准备工作。如果数据重复,WebHarvy 会自动抓取。导出捕获的数据可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy URL 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文档。您还可以抓取数据并将其导出到 SQL 数据库。从多个页面中提取通用网页显示信息数据,例如多个页面中的产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。只强调“连接到下一页”,WebHarvy URL 抓取器会自动从所有页面抓取数据。可视化操作面板WebHarvy是一款用于数据可视化网页提取的专用工具。实际上,没有必要编写所有脚本。或者编码用于提取数据。使用 webharvy 的嵌入式计算机浏览器访问网页。您可以选择通过单击鼠标来提取数据。

这太容易了!根据关键词提取 根据关键词提取,可以抓取百度搜索页面关键词输入的列表数据。您创建的设备将自动重复输入所有输入 关键词 和发现的数据。能够指定一个随机的总输入 关键词 提取分类 WebHarvy URL 抓取器允许您从链接列表中提取数据,从而在 网站 内生成类似的页面。这使您能够在抓取的 URL 中应用单一类型或副标题。使用正则表达式提取 WebHarvy 可以在文本或网页的 HTML 源代码中使用正则表达式(正则表达式),并提取匹配的一部分。这种技术性很强,说明你协调能力很强,数据也很顶尖。[软件特点] WebHarvy 是一款视觉效果的网络爬虫。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。非常容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。非常容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。

您还可以将抓取到的数据导出到 SQL 数据库。通常,网页在多个页面上显示诸如信息产品列表之类的数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需强调“连接到下一页”,WebHarvy Web Scraper 就会自动从所有页面抓取数据。【版本更新】恢复页面启动时可以禁止使用链接。可以为page方法配备专用的接口方法。它可以自动检索可以在 HTML 上提供的资源。改进电脑键盘向下翻页功能改进基于Java脚本制作的下一页加载。添加URL设备后,可以在列表2搜索中输入关键词

网页抓取数据 免费(智能识别方式WebHarvy自动检索)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-11-06 05:04

WebHarvy 是网页数据爬取的专用工具。该软件可以提取网页中的文字和图片,输入网址即可打开。默认设置为使用电脑内置浏览器,适合扩展分析,可自动获取类似连接列表。程序界面 可视化的实际操作很容易。【功能介绍】智能识别方法WebHarvy自动检索网页中出现的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则不需要做所有额外的准备工作。如果数据重复,WebHarvy 会自动抓取。导出捕获的数据可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy URL 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文档。您还可以抓取数据并将其导出到 SQL 数据库。从多个页面中提取通用网页显示信息数据,例如多个页面中的产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。只强调“连接到下一页”,WebHarvy URL 抓取器会自动从所有页面抓取数据。可视化操作面板WebHarvy是一款用于数据可视化网页提取的专用工具。实际上,没有必要编写所有脚本。或者编码用于提取数据。使用 webharvy 的嵌入式计算机浏览器访问网页。您可以选择通过单击鼠标来提取数据。

这太容易了!根据关键词提取 根据关键词提取,可以抓取百度搜索页面关键词输入的列表数据。您创建的设备将自动重复输入所有输入 关键词 和发现的数据。能够指定一个随机的总输入 关键词 提取分类 WebHarvy URL 抓取器允许您从链接列表中提取数据,从而在 网站 内生成类似的页面。这使您能够在抓取的 URL 中应用单一类型或副标题。使用正则表达式提取 WebHarvy 可以在文本或网页的 HTML 源代码中使用正则表达式(正则表达式),并提取匹配的一部分。这种技术性很强,说明你协调能力很强,数据也很顶尖。[软件特点] WebHarvy 是一款视觉效果的网络爬虫。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。非常容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。非常容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。

您还可以将抓取到的数据导出到 SQL 数据库。通常,网页在多个页面上显示诸如信息产品列表之类的数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需强调“连接到下一页”,WebHarvy Web Scraper 就会自动从所有页面抓取数据。【版本更新】恢复页面启动时可以禁止使用链接。可以为page方法配备专用的接口方法。它可以自动检索可以在 HTML 上提供的资源。改进电脑键盘向下翻页功能改进基于Java脚本制作的下一页加载。添加URL设备后,可以在列表2搜索中输入关键词 查看全部

网页抓取数据 免费(智能识别方式WebHarvy自动检索)

WebHarvy 是网页数据爬取的专用工具。该软件可以提取网页中的文字和图片,输入网址即可打开。默认设置为使用电脑内置浏览器,适合扩展分析,可自动获取类似连接列表。程序界面 可视化的实际操作很容易。【功能介绍】智能识别方法WebHarvy自动检索网页中出现的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则不需要做所有额外的准备工作。如果数据重复,WebHarvy 会自动抓取。导出捕获的数据可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy URL 抓取器允许您将抓取的数据导出为 XML、CSV、JSON 或 TSV 文档。您还可以抓取数据并将其导出到 SQL 数据库。从多个页面中提取通用网页显示信息数据,例如多个页面中的产品目录。WebHarvy 可以自动从多个网页中抓取和提取数据。只强调“连接到下一页”,WebHarvy URL 抓取器会自动从所有页面抓取数据。可视化操作面板WebHarvy是一款用于数据可视化网页提取的专用工具。实际上,没有必要编写所有脚本。或者编码用于提取数据。使用 webharvy 的嵌入式计算机浏览器访问网页。您可以选择通过单击鼠标来提取数据。

这太容易了!根据关键词提取 根据关键词提取,可以抓取百度搜索页面关键词输入的列表数据。您创建的设备将自动重复输入所有输入 关键词 和发现的数据。能够指定一个随机的总输入 关键词 提取分类 WebHarvy URL 抓取器允许您从链接列表中提取数据,从而在 网站 内生成类似的页面。这使您能够在抓取的 URL 中应用单一类型或副标题。使用正则表达式提取 WebHarvy 可以在文本或网页的 HTML 源代码中使用正则表达式(正则表达式),并提取匹配的一部分。这种技术性很强,说明你协调能力很强,数据也很顶尖。[软件特点] WebHarvy 是一款视觉效果的网络爬虫。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。绝对不需要编写所有脚本或编码来抓取数据。您将使用 WebHarvy 的嵌入式计算机浏览器访问网页。您可以选择关键数据。这很容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。非常容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。非常容易!WebHarvy 自动检索网页中生成的数据。因此,如果您必须从网页中抓取新项目的列表(名称、完整地址、电子邮件地址、价格等),则无需实施所有其他设备。如果数据重复,WebHarvy 会自动删除它。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。您可以以各种文件格式存储从网页中提取的数据。当前版本的 WebHarvy Web Scraper 允许您将抓取的数据导出为 Excel、XML、CSV、JSON 或 TSV 文档。

您还可以将抓取到的数据导出到 SQL 数据库。通常,网页在多个页面上显示诸如信息产品列表之类的数据。WebHarvy 可以自动从多个页面抓取和提取数据。只需强调“连接到下一页”,WebHarvy Web Scraper 就会自动从所有页面抓取数据。【版本更新】恢复页面启动时可以禁止使用链接。可以为page方法配备专用的接口方法。它可以自动检索可以在 HTML 上提供的资源。改进电脑键盘向下翻页功能改进基于Java脚本制作的下一页加载。添加URL设备后,可以在列表2搜索中输入关键词

网页抓取数据 免费(请求头,用来说明服务器要使用的附加信息..)

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2021-11-05 13:03

请求头用于描述服务器将使用的附加信息。专注于:Accept、Cookie、Referer、User-Agent

1.Accept:请求头域,用于指定客户端可以接受什么类型的信息。# 重点 (*/*)

2.Cookies:Cookies 也常用复数形式。这是存储在用户本地网站的数据,用于识别用户进行会话跟踪。它的主要功能是维护当前的访问会话。例如,我们通过输入用户名和密码成功登录到某个网站后,服务器会在一个会话中保存登录状态信息,每次刷新或请求该站点的其他页面时,我们会发现是登录状态。这是 Cookie 的功劳。Cookies 中有识别我们相应服务器会话的信息。浏览器每次请求本站的一个页面时,都会在请求头中添加 Cookies 并发送给服务器。服务器通过 Cookies 识别出它是我们自己。

3.Referer:此内容用于标识发出请求的页面。服务端可以得到这些信息并做相应的处理,比如源码统计、反盗链处理等#Focus

4.User-Agent:简称UA,是一个特殊的字符串头,可以让服务器识别客户端使用的操作系统和版本、浏览器和版本。当你在做爬虫的时候添加这些信息,就可以冒充浏览器了;如果不添加,很可能会被识别为爬虫#key

5.x-requested-with :XMLHttpRequest #代表ajax请求

5.Accept-Language:指定客户端可接受的语言类型。

6.Accept-Encoding:指定客户端可接受的内容编码

7.Content-Type:也称为 Internet 媒体类型或 MIME 类型。在HTTP协议消息头中,用于指示特定请求中的媒体类型信息。比如text/html代表HTML格式,image/gif代表GIF图片,application/json代表JSON类型 查看全部

网页抓取数据 免费(请求头,用来说明服务器要使用的附加信息..)

请求头用于描述服务器将使用的附加信息。专注于:Accept、Cookie、Referer、User-Agent

1.Accept:请求头域,用于指定客户端可以接受什么类型的信息。# 重点 (*/*)

2.Cookies:Cookies 也常用复数形式。这是存储在用户本地网站的数据,用于识别用户进行会话跟踪。它的主要功能是维护当前的访问会话。例如,我们通过输入用户名和密码成功登录到某个网站后,服务器会在一个会话中保存登录状态信息,每次刷新或请求该站点的其他页面时,我们会发现是登录状态。这是 Cookie 的功劳。Cookies 中有识别我们相应服务器会话的信息。浏览器每次请求本站的一个页面时,都会在请求头中添加 Cookies 并发送给服务器。服务器通过 Cookies 识别出它是我们自己。

3.Referer:此内容用于标识发出请求的页面。服务端可以得到这些信息并做相应的处理,比如源码统计、反盗链处理等#Focus

4.User-Agent:简称UA,是一个特殊的字符串头,可以让服务器识别客户端使用的操作系统和版本、浏览器和版本。当你在做爬虫的时候添加这些信息,就可以冒充浏览器了;如果不添加,很可能会被识别为爬虫#key

5.x-requested-with :XMLHttpRequest #代表ajax请求

5.Accept-Language:指定客户端可接受的语言类型。

6.Accept-Encoding:指定客户端可接受的内容编码

7.Content-Type:也称为 Internet 媒体类型或 MIME 类型。在HTTP协议消息头中,用于指示特定请求中的媒体类型信息。比如text/html代表HTML格式,image/gif代表GIF图片,application/json代表JSON类型

网页抓取数据 免费(百度搜索一下网站、这些网站的原始数据集基本在上开源)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-11-02 04:02

网页抓取数据免费的,但是里面的数据量都很大。推荐的话,百度搜索一下网站、这些网站的原始数据集基本在github上开源的。

网页爬虫可以搜yii-web开发框架,搜一下这个开源项目里面有现成的classlist库。你要做的就是把这个classlist库和几个主流网站的地址拷贝过来,写个程序抓取他们的页面。

因为一些原因,本人最近在学习web爬虫。免费的大多是基于你要爬的网站来实现的。例如百度。搜狗。网页那么多,你完全无需爬,用你需要的库即可(例如:爬虫利器nodejs)。但是我要给出我个人对免费爬虫的看法,供大家参考:1,要赚钱,除非你有强大的客户信息源,能够累积和保存这些信息。2,有钱,别等着赚钱。例如,你想做个高端定制产品,然后你得有产品图片,比如金白银才能支持你实现。

正常的网站,一页有很多网页,为了爬取更多的数据,你首先得充分了解你要爬取的数据,这个要求完全没有技术性。最少得去大学考一下认证证书吧。

互联网平台都可以爬取啊,比如公司网站,个人网站。很多哦。

数据类型可能不一样,有otp,像读取邮件就要读取发件人数据,然后做标注。免费开源的东西不用害怕, 查看全部

网页抓取数据 免费(百度搜索一下网站、这些网站的原始数据集基本在上开源)

网页抓取数据免费的,但是里面的数据量都很大。推荐的话,百度搜索一下网站、这些网站的原始数据集基本在github上开源的。

网页爬虫可以搜yii-web开发框架,搜一下这个开源项目里面有现成的classlist库。你要做的就是把这个classlist库和几个主流网站的地址拷贝过来,写个程序抓取他们的页面。

因为一些原因,本人最近在学习web爬虫。免费的大多是基于你要爬的网站来实现的。例如百度。搜狗。网页那么多,你完全无需爬,用你需要的库即可(例如:爬虫利器nodejs)。但是我要给出我个人对免费爬虫的看法,供大家参考:1,要赚钱,除非你有强大的客户信息源,能够累积和保存这些信息。2,有钱,别等着赚钱。例如,你想做个高端定制产品,然后你得有产品图片,比如金白银才能支持你实现。

正常的网站,一页有很多网页,为了爬取更多的数据,你首先得充分了解你要爬取的数据,这个要求完全没有技术性。最少得去大学考一下认证证书吧。

互联网平台都可以爬取啊,比如公司网站,个人网站。很多哦。

数据类型可能不一样,有otp,像读取邮件就要读取发件人数据,然后做标注。免费开源的东西不用害怕,

网页抓取数据 免费(风越网页批量填写数据提取软件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-10-31 06:00

风悦网页批量填充数据提取软件是小编为大家带来的一款非常实用的网页数据提取工具。它可以帮助您轻松提取网页数据。需要的话就下载吧。

软件特点

风悦网页批量填充数据提取软件支持更多的页面填充类型和控制元素,准确率更高。其他填表工具一般不支持:多框页面(frame)、多选列表、HTML文本(iframe)输入法,本软件一般都能正确填写。本软件不仅可以用于一般办公填表,还可以扩展为批量注册、投票、留言、商品秒杀、舆情控制、征信、抢车牌等工具。

特征

支持从Excel和ACCESS文件中读取数据填写表格,并可根据当前表格生成xls文件,方便批量录入

支持下载指定文件和抓取网页文本内容

支持填充多边框页面中的控件元素

支持在嵌入框架iframe的页面中填充控件元素

支持网页结构分析,显示控件的描述,方便分析和修改控件的值

支持各种页面控件元素的填充:

支持文本输入框输入/textarea

支持单选、多选列表多选

支持多选框收音机

支持收音机复选框

支持填写级联下拉菜单

支持填写无ID控制

预防措施

软件需要.NET Framework2.0运行环境,如果不能运行请安装【.NET Framework2.0简体中文版】 查看全部

网页抓取数据 免费(风越网页批量填写数据提取软件)

风悦网页批量填充数据提取软件是小编为大家带来的一款非常实用的网页数据提取工具。它可以帮助您轻松提取网页数据。需要的话就下载吧。

软件特点

风悦网页批量填充数据提取软件支持更多的页面填充类型和控制元素,准确率更高。其他填表工具一般不支持:多框页面(frame)、多选列表、HTML文本(iframe)输入法,本软件一般都能正确填写。本软件不仅可以用于一般办公填表,还可以扩展为批量注册、投票、留言、商品秒杀、舆情控制、征信、抢车牌等工具。

特征

支持从Excel和ACCESS文件中读取数据填写表格,并可根据当前表格生成xls文件,方便批量录入

支持下载指定文件和抓取网页文本内容

支持填充多边框页面中的控件元素

支持在嵌入框架iframe的页面中填充控件元素

支持网页结构分析,显示控件的描述,方便分析和修改控件的值

支持各种页面控件元素的填充:

支持文本输入框输入/textarea

支持单选、多选列表多选

支持多选框收音机

支持收音机复选框

支持填写级联下拉菜单

支持填写无ID控制

预防措施

软件需要.NET Framework2.0运行环境,如果不能运行请安装【.NET Framework2.0简体中文版】

网页抓取数据 免费( 左手用R右手Python系列——模拟登陆教务系统R语言爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-10-27 03:12

左手用R右手Python系列——模拟登陆教务系统R语言爬虫)

左手R和右手Python系列-模拟登录教务系统

R语言爬虫实战-网易云课堂数据分析课程数据爬取

请注意,在当今的 Web 前端中,使用 json 作为数据包返回的 API 太常见了。这个问题一直困扰着我。我什至以为RCurl包的POST方法不支持上传json参数(但是RCurl是直接Docking liburl,通用爬虫C语言库,还有urllib,httr底层使用RCurl,RCurl那个httr能做的自然没问题)

一定是作者隐藏了json参数的上传方式,或者还没来得及封装成高层函数,放到底层,否则解释不通。直到今天,我在Linkedlin上浏览了一篇大神写的文章,突然间我的灵感突然出现了。我快速尝试了一下,真的成功了!验证了之前的想法,可能RCurl刚出道的时候,json还没有成为主流,所以json参数没有明显放在style POST方法的参数里面。 httr包很容易声明所有POST参数的编码(哈德利大神快了一步,造福人类)。

/pulse/web-data-acquisition-structure-rcurl-request-part-2-roberto-palloni

以下是写这篇文章的目的。分享一下使用RCurl包构造POST请求和提交json字符串参数的案例和代码。与httr相比,RCurl库更底层,功能多,繁琐。 httr 更加灵活、轻便、简洁。这种关系与Python中的urllib和request非常相似。

构建标题和查询参数:

<p>library("RCurl")

library("jsonlite")

library("magrittr")

headers 查看全部

网页抓取数据 免费(

左手用R右手Python系列——模拟登陆教务系统R语言爬虫)

左手R和右手Python系列-模拟登录教务系统

R语言爬虫实战-网易云课堂数据分析课程数据爬取

请注意,在当今的 Web 前端中,使用 json 作为数据包返回的 API 太常见了。这个问题一直困扰着我。我什至以为RCurl包的POST方法不支持上传json参数(但是RCurl是直接Docking liburl,通用爬虫C语言库,还有urllib,httr底层使用RCurl,RCurl那个httr能做的自然没问题)

一定是作者隐藏了json参数的上传方式,或者还没来得及封装成高层函数,放到底层,否则解释不通。直到今天,我在Linkedlin上浏览了一篇大神写的文章,突然间我的灵感突然出现了。我快速尝试了一下,真的成功了!验证了之前的想法,可能RCurl刚出道的时候,json还没有成为主流,所以json参数没有明显放在style POST方法的参数里面。 httr包很容易声明所有POST参数的编码(哈德利大神快了一步,造福人类)。

/pulse/web-data-acquisition-structure-rcurl-request-part-2-roberto-palloni

以下是写这篇文章的目的。分享一下使用RCurl包构造POST请求和提交json字符串参数的案例和代码。与httr相比,RCurl库更底层,功能多,繁琐。 httr 更加灵活、轻便、简洁。这种关系与Python中的urllib和request非常相似。

构建标题和查询参数:

<p>library("RCurl")

library("jsonlite")

library("magrittr")

headers

网页抓取数据 免费(远程诊断错误和性能问题有哪些?-八维教育)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-10-26 16:20

HttpWatch 是一个强大的网络数据分析工具。它集成在 Internet Explorer 工具栏中。它包括网页摘要。饼干管理。缓存管理。消息头发送/接收。字符查询。POST 数据和目录管理功能。报告输出。HttpWatch 是一个工具,可以采集和显示深度信息的软件。它不需要代理服务器或一些复杂的网络监控工具,它可以在显示网页的同时显示网页请求和响应的日志信息。它甚至可以显示浏览器缓存和 IE 之间的交换信息。集成在 Internet Explorer 工具栏中。

只需选择对应的网站,软件即可分析网站与IE之间的需求响应通信情况,并在同一界面显示其对应的日志记录。每条 HTTP 记录都可以详细分析其 cookie、消息头、字符查询等信息。支持HTTPS和分析报告输出为XML、CSV等格式。

软件特点

1、网页调试

要调试由网络流量生成的 Web 浏览器,您可以切换到单独的调试工具。

2、性能调优

准确衡量一个网页,从而更好地提升网络性能。

3、简单的无代理设置

没有额外的配置或代理要求——即使使用加密的 HTTPS 流量。

4、安全测试

在您的 Web 服务器上,快速找到弱 SSL 配置和其他与安全相关的问题。

5、免费日志文件共享

任何人都可以免费使用基本版,为您提供完整的日志文件,帮助您远程诊断错误和性能问题。 查看全部

网页抓取数据 免费(远程诊断错误和性能问题有哪些?-八维教育)

HttpWatch 是一个强大的网络数据分析工具。它集成在 Internet Explorer 工具栏中。它包括网页摘要。饼干管理。缓存管理。消息头发送/接收。字符查询。POST 数据和目录管理功能。报告输出。HttpWatch 是一个工具,可以采集和显示深度信息的软件。它不需要代理服务器或一些复杂的网络监控工具,它可以在显示网页的同时显示网页请求和响应的日志信息。它甚至可以显示浏览器缓存和 IE 之间的交换信息。集成在 Internet Explorer 工具栏中。

只需选择对应的网站,软件即可分析网站与IE之间的需求响应通信情况,并在同一界面显示其对应的日志记录。每条 HTTP 记录都可以详细分析其 cookie、消息头、字符查询等信息。支持HTTPS和分析报告输出为XML、CSV等格式。

软件特点

1、网页调试

要调试由网络流量生成的 Web 浏览器,您可以切换到单独的调试工具。

2、性能调优

准确衡量一个网页,从而更好地提升网络性能。

3、简单的无代理设置

没有额外的配置或代理要求——即使使用加密的 HTTPS 流量。

4、安全测试

在您的 Web 服务器上,快速找到弱 SSL 配置和其他与安全相关的问题。

5、免费日志文件共享

任何人都可以免费使用基本版,为您提供完整的日志文件,帮助您远程诊断错误和性能问题。

网页抓取数据 免费(什么语言requesturl获取的数据都是不完整的?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-10-26 00:11

我们知道,如果网页的数据没有通过http协议加载到页面中,或者ajax延迟将数据加载到页面中,这时候你的语言请求url获取的数据是不完整的。

说白了就是无法抓取到需要的目标数据,采用以下两种方法来处理:

方法一:WebBrowser延迟加载采集地址(线程等待)用js处理。

1.目标网址:顺便说一下,这个网站很强大。通过浏览器可以看到作者使用了很多方法来防止爬取和分析。ID复制、访问频率验证、js加密压缩、302跳转、多域配置、非常规命名、节点重复混淆等,市面上常规的方法基本都搞定了(当然我们可以到302跳转,然后爬行,没有问题,这里是非常规的方法)。

2. 如何获取他的数据,HttpWebRequest不工作,你会发现返回的htm为null,我没试过php。

3.通过winfrom的WebBrowser控件加载页面,然后WebBrowser和js交互获取页面数据,然后返回到winfrom控件层本身。

页面加载完成后,我们将js注入到这个页面中,然后通过js获取目标数据,然后将获取到的数据存储在页面上,然后再次调用注册的事件触发数据返回。

1. 在WebBrowser的DocumentCompleted(object sender, WebBrowserDocumentCompletedEventArgs e)事件中注册js脚本:

//注册事件

HtmlElement tbOriginUrl = webBrowser1.Document.All["sn"];

tbOriginUrl.AttachEventHandler("onclick", new EventHandler(SetTextBox));

IHTMLWindow2 win = (IHTMLWindow2)this.webBrowser1.Document.Window.DomWindow;

var scriptcollect = @"var _items = $('.hm1 .hm a').map(function(idx, dom){

var url = $(dom).attr('href');

var like = $.trim($(dom).find('div:eq(1)>span').text().replace(' 人喜欢 ', ''));

var play = $.trim($(dom).find('.su>span').text().replace(' 次播放 ', ''));

var title = $(dom).find('p').text();

var img = $(dom).find('img').attr('name');

return url + '$' + like + '$' + play + '$' + title + '$' + img;

}).get().join('|');

$('#sn').val(_items);

setTimeout(function(){

document.getElementById(""sn"").click();

},2000);";

win.execScript(scriptcollect, "Javascript");

注意需要引入using mshtml;空间(在 Microsoft.mshtml.dll 中)

这个脚本的意思是:

1. 先注册输入框的点击事件

2.找到目标数据对象,然后构造需要的数据

3.将构造好的数据写入输入框

4. 触发输入的点击事件。注意不是立即触发,而是延迟2秒触发。这是非常重要的。

点击事件的具体方法是:

void SetTextBox(object sender, EventArgs e)

{

HtmlElement tbOriginUrl = webBrowser1.Document.All["sn"];

try

{

if (tbOriginUrl != null && tbOriginUrl.OuterHtml != null)

{

var temp = tbOriginUrl.OuterHtml.Trim() //

.Replace(" ", "")

.Replace("\" required> ", "");

this.textBox1.Text = temp.Trim();

analysis(temp.Trim());

pageidx++; //变更页码

}

}

catch (Exception ex)

{

LogHelp.Log(ex);

}

//调用下一个页面...

}

先获取目标输入框的数据,然后解析,再写入数据库。

这里有2个建议:

1. 解析得到的数据后,建议将其存储在内存级存储对象中,例如memcached,然后单独开启一个服务将memcached中的数据写入数据库(例如mysql),从而可以减少采集循环时间速度会更快;

2.如何触发循环去采集,我无法在SetTextBox方法的末尾重置WebBrowser的url,使其可以循环。但有一点非常重要。主人的站点会检查访问该站点的IP和频率,并且一般设置一个阈值。每次 WebBrowser 打开页面时,您都需要仔细调整间隔时间。这个建议是将它从 20 秒减少到一个合适的间隔。您可以等待相应的秒数,然后再允许 WebBrowser 打开新页面。在这里您可以添加一个技巧是在间隔时间中添加一个随机秒,以防间隔时间每次都相同。

方法二:

1.谷歌浏览器打开开发者调试面板(F12),切换到页面的sources部分,然后在Snippets中编写可以获取目标页面数据的js方法,具体数据结构模型需要自己整理。

2.winfrom 写了一个小程序,获取当前打开目标采集页面的浏览器的句柄,通过句柄找到对象,显然是1布写的js

然后通过win api调用run方法,然后在Console中得到结果。

该方法的难点在于调用windows api获取窗口并触发事件。如果你熟悉它,那就没有什么了。现在的各种QQ机器人或者微信自动发送的小机器人都是这个思路。打开QQ(或微信),获取句柄,找到对象,动态写入文本,然后调用目标按钮触发事件。信息。 查看全部

网页抓取数据 免费(什么语言requesturl获取的数据都是不完整的?)

我们知道,如果网页的数据没有通过http协议加载到页面中,或者ajax延迟将数据加载到页面中,这时候你的语言请求url获取的数据是不完整的。

说白了就是无法抓取到需要的目标数据,采用以下两种方法来处理:

方法一:WebBrowser延迟加载采集地址(线程等待)用js处理。

1.目标网址:顺便说一下,这个网站很强大。通过浏览器可以看到作者使用了很多方法来防止爬取和分析。ID复制、访问频率验证、js加密压缩、302跳转、多域配置、非常规命名、节点重复混淆等,市面上常规的方法基本都搞定了(当然我们可以到302跳转,然后爬行,没有问题,这里是非常规的方法)。

2. 如何获取他的数据,HttpWebRequest不工作,你会发现返回的htm为null,我没试过php。

3.通过winfrom的WebBrowser控件加载页面,然后WebBrowser和js交互获取页面数据,然后返回到winfrom控件层本身。

页面加载完成后,我们将js注入到这个页面中,然后通过js获取目标数据,然后将获取到的数据存储在页面上,然后再次调用注册的事件触发数据返回。

1. 在WebBrowser的DocumentCompleted(object sender, WebBrowserDocumentCompletedEventArgs e)事件中注册js脚本:

//注册事件

HtmlElement tbOriginUrl = webBrowser1.Document.All["sn"];

tbOriginUrl.AttachEventHandler("onclick", new EventHandler(SetTextBox));

IHTMLWindow2 win = (IHTMLWindow2)this.webBrowser1.Document.Window.DomWindow;

var scriptcollect = @"var _items = $('.hm1 .hm a').map(function(idx, dom){

var url = $(dom).attr('href');

var like = $.trim($(dom).find('div:eq(1)>span').text().replace(' 人喜欢 ', ''));

var play = $.trim($(dom).find('.su>span').text().replace(' 次播放 ', ''));

var title = $(dom).find('p').text();

var img = $(dom).find('img').attr('name');

return url + '$' + like + '$' + play + '$' + title + '$' + img;

}).get().join('|');

$('#sn').val(_items);

setTimeout(function(){

document.getElementById(""sn"").click();

},2000);";

win.execScript(scriptcollect, "Javascript");

注意需要引入using mshtml;空间(在 Microsoft.mshtml.dll 中)

这个脚本的意思是:

1. 先注册输入框的点击事件

2.找到目标数据对象,然后构造需要的数据

3.将构造好的数据写入输入框

4. 触发输入的点击事件。注意不是立即触发,而是延迟2秒触发。这是非常重要的。

点击事件的具体方法是:

void SetTextBox(object sender, EventArgs e)

{

HtmlElement tbOriginUrl = webBrowser1.Document.All["sn"];

try

{

if (tbOriginUrl != null && tbOriginUrl.OuterHtml != null)

{

var temp = tbOriginUrl.OuterHtml.Trim() //

.Replace(" ", "")

.Replace("\" required> ", "");

this.textBox1.Text = temp.Trim();

analysis(temp.Trim());

pageidx++; //变更页码

}

}

catch (Exception ex)

{

LogHelp.Log(ex);

}

//调用下一个页面...

}

先获取目标输入框的数据,然后解析,再写入数据库。

这里有2个建议:

1. 解析得到的数据后,建议将其存储在内存级存储对象中,例如memcached,然后单独开启一个服务将memcached中的数据写入数据库(例如mysql),从而可以减少采集循环时间速度会更快;

2.如何触发循环去采集,我无法在SetTextBox方法的末尾重置WebBrowser的url,使其可以循环。但有一点非常重要。主人的站点会检查访问该站点的IP和频率,并且一般设置一个阈值。每次 WebBrowser 打开页面时,您都需要仔细调整间隔时间。这个建议是将它从 20 秒减少到一个合适的间隔。您可以等待相应的秒数,然后再允许 WebBrowser 打开新页面。在这里您可以添加一个技巧是在间隔时间中添加一个随机秒,以防间隔时间每次都相同。

方法二:

1.谷歌浏览器打开开发者调试面板(F12),切换到页面的sources部分,然后在Snippets中编写可以获取目标页面数据的js方法,具体数据结构模型需要自己整理。

2.winfrom 写了一个小程序,获取当前打开目标采集页面的浏览器的句柄,通过句柄找到对象,显然是1布写的js

然后通过win api调用run方法,然后在Console中得到结果。

该方法的难点在于调用windows api获取窗口并触发事件。如果你熟悉它,那就没有什么了。现在的各种QQ机器人或者微信自动发送的小机器人都是这个思路。打开QQ(或微信),获取句柄,找到对象,动态写入文本,然后调用目标按钮触发事件。信息。

网页抓取数据 免费(网页抓取数据免费方法多种多样,整合多套能够转换的网站网站)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-11-14 00:01

网页抓取数据免费方法多种多样,整合多套能够转换的网站网站便于定制自动化抓取,如。anyway。小码哥整理了部分共有8套(前端网站,常用)1.可汗学院最大的视频学习网站2.扇贝单词分享提供各种英语学习资料,你可以使用扇贝打卡,也可以搜集自己喜欢的词汇卡片或单词库。有一个好评最多的版本。3.沪江开心词场每日打卡提高词汇量,也推出了买词典,买红砖或买小词典的优惠活动。

4.21天搞定考研词汇一个提供金融、经济、计算机、心理学等领域词汇相关的自学网站。每天一个金融词汇小卡片,帮助您更好地记忆金融词汇。如:金融知识卡片提供了简单有趣的金融数据分析5.simplex-im官方推荐的一个英语学习网站。内容涵盖四六级、考研,托福、雅思。里面有好多不同的题目供选择。6.每日英语听力网站提供包括chinadaily在内的英语新闻,每天英语听力点播(从ft中文网收听)或听写。

7.沪江英语网专注于提供实用工具,多种学习资源,视频学习,听力学习,有quizlet,付费阅读。8.每日一句每天推送四六级句子,适合有基础的高中学生。(搞笑语句类)内容:每日一句(所有资源均收费)资源分享(有水印)end扫码关注小码哥。

1.传智播客学院(这个我深有体会,如今时间紧张,我用过,体验很好,值得学习,但是网上也有很多人说不靠谱)2.百度传课(只推荐三个大网站,百度传课、网易公开课、腾讯公开课)3.多贝网(针对,也有电台类)4.优米网(针对视频)5.非凡教程大全(针对视频)6.我要自学网(开学季找好多教程,还有课堂视频)7.小站教育(很不错)8.英语流利说(从四六级、托福、托业、雅思考试以及口语学习)9.中国大学mooc(可以看公开课和慕课,分类很细致)10.51自学网(有很多优秀的公开课和慕课)11.网易公开课(找网易公开课的网站)12.中国大学mooc(可以找公开课的网站)13.东吴慕课网(基本所有的网课都有)14.百度网盘(百度网盘,网盘大神的居住地)15.喜马拉雅fm(听各种名人讲课,尤其是ppt课和万门大学等,很受启发)16.荔枝fm(每天都有新话题,听各类名人讲课,尤其是罗振宇,任何人学到东西都是收获)17.音悦台(注意,现在已经从幕后走向台前了,有很多专业音乐人做专辑,可以看一些资源)18.暴风影音(可以看盗版片)19.海绵学院(分享给同学,自己再下载几部,现在正在这么干,比如大话西游2,星球大战7等)20.万能mp3搜索(听见自己的声音,可以算是一个黑科技,虽然一直知道,但一直没想到。)21.非凡大数。 查看全部

网页抓取数据 免费(网页抓取数据免费方法多种多样,整合多套能够转换的网站网站)

网页抓取数据免费方法多种多样,整合多套能够转换的网站网站便于定制自动化抓取,如。anyway。小码哥整理了部分共有8套(前端网站,常用)1.可汗学院最大的视频学习网站2.扇贝单词分享提供各种英语学习资料,你可以使用扇贝打卡,也可以搜集自己喜欢的词汇卡片或单词库。有一个好评最多的版本。3.沪江开心词场每日打卡提高词汇量,也推出了买词典,买红砖或买小词典的优惠活动。

4.21天搞定考研词汇一个提供金融、经济、计算机、心理学等领域词汇相关的自学网站。每天一个金融词汇小卡片,帮助您更好地记忆金融词汇。如:金融知识卡片提供了简单有趣的金融数据分析5.simplex-im官方推荐的一个英语学习网站。内容涵盖四六级、考研,托福、雅思。里面有好多不同的题目供选择。6.每日英语听力网站提供包括chinadaily在内的英语新闻,每天英语听力点播(从ft中文网收听)或听写。

7.沪江英语网专注于提供实用工具,多种学习资源,视频学习,听力学习,有quizlet,付费阅读。8.每日一句每天推送四六级句子,适合有基础的高中学生。(搞笑语句类)内容:每日一句(所有资源均收费)资源分享(有水印)end扫码关注小码哥。

1.传智播客学院(这个我深有体会,如今时间紧张,我用过,体验很好,值得学习,但是网上也有很多人说不靠谱)2.百度传课(只推荐三个大网站,百度传课、网易公开课、腾讯公开课)3.多贝网(针对,也有电台类)4.优米网(针对视频)5.非凡教程大全(针对视频)6.我要自学网(开学季找好多教程,还有课堂视频)7.小站教育(很不错)8.英语流利说(从四六级、托福、托业、雅思考试以及口语学习)9.中国大学mooc(可以看公开课和慕课,分类很细致)10.51自学网(有很多优秀的公开课和慕课)11.网易公开课(找网易公开课的网站)12.中国大学mooc(可以找公开课的网站)13.东吴慕课网(基本所有的网课都有)14.百度网盘(百度网盘,网盘大神的居住地)15.喜马拉雅fm(听各种名人讲课,尤其是ppt课和万门大学等,很受启发)16.荔枝fm(每天都有新话题,听各类名人讲课,尤其是罗振宇,任何人学到东西都是收获)17.音悦台(注意,现在已经从幕后走向台前了,有很多专业音乐人做专辑,可以看一些资源)18.暴风影音(可以看盗版片)19.海绵学院(分享给同学,自己再下载几部,现在正在这么干,比如大话西游2,星球大战7等)20.万能mp3搜索(听见自己的声音,可以算是一个黑科技,虽然一直知道,但一直没想到。)21.非凡大数。

网页抓取数据 免费(Windows,OSX及Linux操作系统或mobi格式的在线阅读)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-11-13 00:18

自从我买了kindle,我就一直在想如何最大限度地发挥它的功效。虽然可供购买的书籍很多,网上也有很多免费的电子书,但还是有很多有趣的内容以网页的形式出现。例如,O'Reilly Atlas 提供了很多电子书,但只提供免费在线阅读;此外,许多材料或文件只是网络形式。所以我希望将这些网上资料以某种方式转换成epub或者mobi格式,以便在kindle上阅读。本文文章介绍了如何使用calibre并编写少量代码来实现这一目标。

Calibre 简介

Calibre 是一款免费的电子书管理工具,兼容 Windows、OS X 和 Linux。令人欣慰的是,除了GUI,calibre 还提供了很多命令行工具。ebook-convert 命令可以基于用户编写的食谱。该文件(实际上是python代码)抓取指定页面的内容,生成mobi等格式的电子书。爬取行为可以通过编写recipe来定制,以适应不同的网页结构。

安装口径

Calibre的下载地址是,您可以根据自己的操作系统下载相应的安装程序。

如果是Linux操作系统,也可以通过软件仓库安装:

Archlinux:

pacman -S calibre

Debian/Ubuntu:

apt-get install calibre

红帽/Fedora/CentOS:

yum -y install calibre

请注意,如果您使用 OSX,则需要单独安装命令行工具。

抓取网页以生成电子书

下面以Git Pocket Guide为例,说明如何通过calibre从网页生成电子书。

找到索引页

要爬取整本书,首先要找到索引页。这个页面一般是目录,也就是目录页面,其中每个目录链接都连接到相应的内容页面。在生成电子书时,索引页会指导抓取哪些页面以及内容组织的顺序。在这个例子中,索引页是。

写食谱

食谱是一个带有食谱扩展名的脚本。内容其实是一段python代码,定义了calibre爬取页面的范围和行为。以下是爬取 Git Pocket Guide 的秘籍:

from calibre.web.feeds.recipes import BasicNewsRecipe

class Git_Pocket_Guide(BasicNewsRecipe):

title = 'Git Pocket Guide'

description = ''

cover_url = 'http://akamaicovers.oreilly.co ... 39%3B

url_prefix = 'http://chimera.labs.oreilly.co ... 39%3B

no_stylesheets = True

keep_only_tags = [{ 'class': 'chapter' }]

def get_title(self, link):

return link.contents[0].strip()

def parse_index(self):

soup = self.index_to_soup(self.url_prefix + 'index.html')

div = soup.find('div', { 'class': 'toc' })

articles = []

for link in div.findAll('a'):

if '#' in link['href']:

continue

if not 'ch' in link['href']:

continue

til = self.get_title(link)

url = self.url_prefix + link['href']

a = { 'title': til, 'url': url }

articles.append(a)

ans = [('Git_Pocket_Guide', articles)]

return ans

下面解释了代码的不同部分。

整体结构

一般来说,一个recipe是一个python类,但是这个类必须继承calibre.web.feeds.recipes.BasicNewsRecipe。

解析索引

整个recipe的核心方法是parse_index,这也是recipes必须实现的唯一方法。该方法的目标是通过分析索引页的内容,返回一个稍微复杂一些的数据结构(稍后介绍)。这个数据结构定义了整个电子书的内容和内容组织顺序。

整体属性设置

在类的开头,定义了一些全局属性:

title = 'Git Pocket Guide'

description = ''

cover_url = 'http://akamaicovers.oreilly.co ... 39%3B

url_prefix = 'http://chimera.labs.oreilly.co ... 39%3B

no_stylesheets = True

keep_only_tags = [{ 'class': 'chapter' }]

parse_index 返回值

下面通过分析索引页来描述parse_index需要返回的数据结构。