文章采集api

一篇文章教会你用Python多线程获取小米应用商店App

采集交流 • 优采云 发表了文章 • 0 个评论 • 192 次浏览 • 2020-08-21 12:12

【一、项目背景】

小米应用商店给用户发觉最好的安卓应用和游戏,安全可靠,可是要下载东西要一个一个的搜索太麻烦了。而已速率不是很快。

今天用多线程爬取小米应用商店的游戏模块。快速获取。

【二、项目目标】

目标 :应用分类 - 聊天社交 应用名称, 应用链接,显示在控制台供用户下载。

【三、涉及的库和网站】

1、网址:百度搜 - 小米应用商店,进入官网。

2、涉及的库:reques****ts、threading 、queue 、json、time

3、软件:PyCharm

【四、项目剖析】

1、确认是否为动态加载。

通过页面局部刷新, 右键查看网页源代码,搜索关键字未搜到 。断定此网站为动态加载网站,需要抓取网路数据包剖析。

2、使用chrome浏览器,F12抓取网路数据包。

1)抓取返回json数据的URL地址(Headers中的Request URL)。

http://app.mi.com/categotyAllListApi?page={}&categoryId=2&pageSize=30

2)查看并剖析查询参数(headers中的Query String Parameters)。

page: 1

categoryId: 2

pageSize: 30

发现只有page再变,0 1 2 3 ... ... ,这样我们就可以通过控制page的直拼接多个返回json数据的URL地址。

【五、项目施行】

1、我们定义一个class类承继object,然后定义init方式承继self,再定义一个主函数main承继self。准备导出库,url地址和恳求头headers。

import requests

from threading import Thread

from queue import Queue

import json

import time

class XiaomiSpider(object):

def __init__(self):

self.headers = {'User-Agent':'Mozilla/5.0'}

self.url = 'http://app.mi.com/categotyAllListApi?page={}&categoryId=15&pageSize=30'

def main(self):

pass

if __name__ == '__main__':

imageSpider = XiaomiSpider()

imageSpider.main()

2、定义队列,用来储存URL地址

self.url_queue = Queue()

3、URL入队列

def url_in(self):

# 拼接多个URL地址,然后put()到队列中

for i in range(67):

self.url.format((str(i)))

self.url_queue.put(self.url)

4、定义线程风波函数get_page(请求数据)

def get_page(self):

# 先get()URL地址,发请求

while True:

# 当队列不为空时,获取url地址

if not self.url_queue.empty():

url = self.url_queue.get()

html = requests.get(url,headers=self.headers).text

self.parse_page(html)

else:

break

5、定义函数parse_page 解析json模块,提取应用名称,应用链接内容。

# 解析函数

def parse_page(self,html):

app_json = json.loads(html)

for app in app_json['data']:

# 应用名称

name = app['displayName']

# 应用链接

link = 'http://app.mi.com/details?id={}'.format(app['packageName'])

d = { '名称' : name,'链接' : link }

print(d)

6、main方式, 定义t_list = [] 存放所有线程的列表。调用get_page多线程爬取。

def main(self):

self.url_in()

# 存放所有线程的列表

t_list = []

for i in range(10):

t = Thread(target=self.get_page)

t.start()

t_list.append(t)

7、for循环遍历列表,统一回收线程。

# 统一回收线程

for p in t_list:

p.join()

8、统计一下执行时间。

start = time.time()

spider = XiaomiSpider()

spider.main()

end = time.time()

print('执行时间:%.2f' % (end-start))

【六、效果展示】

1、运行程序。点击运行,将游戏名称,下载链接,执行时间,显示在控制台。

2、点击红色的网址可以直接去到下载页面下载应用,如下图所示。

【七、总结】

1、不建议抓取太多数据,容易对服务器导致负载,浅尝辄止即可。

2、Python多线程优点。使用线程可以把抢占长时间的程序中的任务放在后台去处,程序的运行速率可能推动。

3、单线程可以被占领(中断),而已多线程就有了更多的选择。而已在其他线程正在运行时,线程可以暂时搁置(也称为睡眠)。可以释放一些珍稀的资源如显存占用。

4、大家也可以尝试在爬取其他分类,按照操作步骤,自己尝试去做。自己实现的时侯,总会有各种各样的问题,切勿眼高手低,勤动手,才可以理解的愈发深刻。 查看全部

一篇文章教会你用Python多线程获取小米应用商店App

【一、项目背景】

小米应用商店给用户发觉最好的安卓应用和游戏,安全可靠,可是要下载东西要一个一个的搜索太麻烦了。而已速率不是很快。

今天用多线程爬取小米应用商店的游戏模块。快速获取。

【二、项目目标】

目标 :应用分类 - 聊天社交 应用名称, 应用链接,显示在控制台供用户下载。

【三、涉及的库和网站】

1、网址:百度搜 - 小米应用商店,进入官网。

2、涉及的库:reques****ts、threading 、queue 、json、time

3、软件:PyCharm

【四、项目剖析】

1、确认是否为动态加载。

通过页面局部刷新, 右键查看网页源代码,搜索关键字未搜到 。断定此网站为动态加载网站,需要抓取网路数据包剖析。

2、使用chrome浏览器,F12抓取网路数据包。

1)抓取返回json数据的URL地址(Headers中的Request URL)。

http://app.mi.com/categotyAllListApi?page={}&categoryId=2&pageSize=30

2)查看并剖析查询参数(headers中的Query String Parameters)。

page: 1

categoryId: 2

pageSize: 30

发现只有page再变,0 1 2 3 ... ... ,这样我们就可以通过控制page的直拼接多个返回json数据的URL地址。

【五、项目施行】

1、我们定义一个class类承继object,然后定义init方式承继self,再定义一个主函数main承继self。准备导出库,url地址和恳求头headers。

import requests

from threading import Thread

from queue import Queue

import json

import time

class XiaomiSpider(object):

def __init__(self):

self.headers = {'User-Agent':'Mozilla/5.0'}

self.url = 'http://app.mi.com/categotyAllListApi?page={}&categoryId=15&pageSize=30'

def main(self):

pass

if __name__ == '__main__':

imageSpider = XiaomiSpider()

imageSpider.main()

2、定义队列,用来储存URL地址

self.url_queue = Queue()

3、URL入队列

def url_in(self):

# 拼接多个URL地址,然后put()到队列中

for i in range(67):

self.url.format((str(i)))

self.url_queue.put(self.url)

4、定义线程风波函数get_page(请求数据)

def get_page(self):

# 先get()URL地址,发请求

while True:

# 当队列不为空时,获取url地址

if not self.url_queue.empty():

url = self.url_queue.get()

html = requests.get(url,headers=self.headers).text

self.parse_page(html)

else:

break

5、定义函数parse_page 解析json模块,提取应用名称,应用链接内容。

# 解析函数

def parse_page(self,html):

app_json = json.loads(html)

for app in app_json['data']:

# 应用名称

name = app['displayName']

# 应用链接

link = 'http://app.mi.com/details?id={}'.format(app['packageName'])

d = { '名称' : name,'链接' : link }

print(d)

6、main方式, 定义t_list = [] 存放所有线程的列表。调用get_page多线程爬取。

def main(self):

self.url_in()

# 存放所有线程的列表

t_list = []

for i in range(10):

t = Thread(target=self.get_page)

t.start()

t_list.append(t)

7、for循环遍历列表,统一回收线程。

# 统一回收线程

for p in t_list:

p.join()

8、统计一下执行时间。

start = time.time()

spider = XiaomiSpider()

spider.main()

end = time.time()

print('执行时间:%.2f' % (end-start))

【六、效果展示】

1、运行程序。点击运行,将游戏名称,下载链接,执行时间,显示在控制台。

2、点击红色的网址可以直接去到下载页面下载应用,如下图所示。

【七、总结】

1、不建议抓取太多数据,容易对服务器导致负载,浅尝辄止即可。

2、Python多线程优点。使用线程可以把抢占长时间的程序中的任务放在后台去处,程序的运行速率可能推动。

3、单线程可以被占领(中断),而已多线程就有了更多的选择。而已在其他线程正在运行时,线程可以暂时搁置(也称为睡眠)。可以释放一些珍稀的资源如显存占用。

4、大家也可以尝试在爬取其他分类,按照操作步骤,自己尝试去做。自己实现的时侯,总会有各种各样的问题,切勿眼高手低,勤动手,才可以理解的愈发深刻。

文章采集api 4.5.2 奶盘API

采集交流 • 优采云 发表了文章 • 0 个评论 • 505 次浏览 • 2020-08-19 10:44

接入奶盘API教程

优采云采集支持调用奶盘API接口,处理采集的数据标题和内容等;

提示:第三方API接入功能须要优采云旗舰版套餐才支持使用,用户需自提供第三方插口账号信息(即用户需注册第三方插口,调用第三方插口形成的一切费用,由用户自己承当);

详细使用步骤1. 奶盘API接口配置I、API配置入口:

点击控制台右侧列表的 【第三方服务配置】 ==》点击 【第三方内容API接入】 ==》点击【第三方API配置管理】 ==》 最后点击【+奶盘API】创建插口配置;

II、配置API插口信息:

【购买的授权用户】、【购买的授权码】是从奶盘网后台获取API授权信息;

【API版本】是对应奶盘网订购的套餐:百度优化版,AI智能版;

注意:因奶盘限制每次调用最长65000字符(包括html代码),所以当内容厚度超过时,优采云会分割并分多次调用,此操作会导致api调用次数的降低,费用也会相应降低,这是用户自己须要承当的费用,使用前一定要注意!!!

2. 创建API处理规则

API处理规则,可设置调用API接口处理什么数组的内容;

I、API处理规则入口:

点击控制台右侧列表的 【第三方服务配置】 ==》点击 【第三方内容API接入】 ==》进入【API处理规则管理】页面,最后点击【+添加API处理规则】创建API处理规则;

II、API处理规则配置:

注意:API处理1个主键时,会调用一次API接口,因此不需要的数组建议不要加!

3. API处理规则使用

API处理规则使用方法有两种:手动执行和手动执行:

I、手动执行API处理规则:

在采集任务的 【结果数据&发布】 选项卡内点击【 SEO&API&翻译等工具】按钮==》选择【第三方API执行】栏==》选择相应的API处理规则 ==》执行(数据范围有两种执行方法,批量按发布状态执行和按列表所选数据执行);

II、自动执行API处理规则:

启用API处理手动执行,任务完成采集后会手动执行API处理,一般配合定时采集和手动发布功能使用,十分便捷;

在任务的 【自动化:发布&SEO&翻译】选项卡里【自动执行第三方API配置】处==》勾选上【采集后,自动执行API】选项==》选择执行的API处理规则 ==》选择API接口处理的数据范围(一般选择 ‘待发布’ 即可,全部会导致所有数据反复执行多次),最后点击保存即可;

4. API处理后的结果及发布I、查看API插口处理后的结果:

API接口处理后的内容会保存为新数组,如:title处理后新增数组:title_奶盘,content处理后新增数组:content_奶盘,在【结果数据&发布】与数据预览界面都可查看。

提示:API处理规则执行须要一点时间,执行完成后会手动刷新页面出现API接口处理后的新数组;

II、发布API接口处理后内容:

发布文章前,修改发布目标第二步映射字段处,标题和内容选举为API接口处理后新增的对应数组title_奶盘和content_奶盘;

提示:如果发布目标内难以选择新增数组,请在该任务下复制或新建发布目标后,在新发布目标中即可选择到新增数组,详细教程可查看;

优采云导航:优采云采集 优采云控制台 如何使用优采云SEO工具 微信公众号文章采集 今日头条采集 查看全部

文章采集api 4.5.2 奶盘API

接入奶盘API教程

优采云采集支持调用奶盘API接口,处理采集的数据标题和内容等;

提示:第三方API接入功能须要优采云旗舰版套餐才支持使用,用户需自提供第三方插口账号信息(即用户需注册第三方插口,调用第三方插口形成的一切费用,由用户自己承当);

详细使用步骤1. 奶盘API接口配置I、API配置入口:

点击控制台右侧列表的 【第三方服务配置】 ==》点击 【第三方内容API接入】 ==》点击【第三方API配置管理】 ==》 最后点击【+奶盘API】创建插口配置;

II、配置API插口信息:

【购买的授权用户】、【购买的授权码】是从奶盘网后台获取API授权信息;

【API版本】是对应奶盘网订购的套餐:百度优化版,AI智能版;

注意:因奶盘限制每次调用最长65000字符(包括html代码),所以当内容厚度超过时,优采云会分割并分多次调用,此操作会导致api调用次数的降低,费用也会相应降低,这是用户自己须要承当的费用,使用前一定要注意!!!

2. 创建API处理规则

API处理规则,可设置调用API接口处理什么数组的内容;

I、API处理规则入口:

点击控制台右侧列表的 【第三方服务配置】 ==》点击 【第三方内容API接入】 ==》进入【API处理规则管理】页面,最后点击【+添加API处理规则】创建API处理规则;

II、API处理规则配置:

注意:API处理1个主键时,会调用一次API接口,因此不需要的数组建议不要加!

3. API处理规则使用

API处理规则使用方法有两种:手动执行和手动执行:

I、手动执行API处理规则:

在采集任务的 【结果数据&发布】 选项卡内点击【 SEO&API&翻译等工具】按钮==》选择【第三方API执行】栏==》选择相应的API处理规则 ==》执行(数据范围有两种执行方法,批量按发布状态执行和按列表所选数据执行);

II、自动执行API处理规则:

启用API处理手动执行,任务完成采集后会手动执行API处理,一般配合定时采集和手动发布功能使用,十分便捷;

在任务的 【自动化:发布&SEO&翻译】选项卡里【自动执行第三方API配置】处==》勾选上【采集后,自动执行API】选项==》选择执行的API处理规则 ==》选择API接口处理的数据范围(一般选择 ‘待发布’ 即可,全部会导致所有数据反复执行多次),最后点击保存即可;

4. API处理后的结果及发布I、查看API插口处理后的结果:

API接口处理后的内容会保存为新数组,如:title处理后新增数组:title_奶盘,content处理后新增数组:content_奶盘,在【结果数据&发布】与数据预览界面都可查看。

提示:API处理规则执行须要一点时间,执行完成后会手动刷新页面出现API接口处理后的新数组;

II、发布API接口处理后内容:

发布文章前,修改发布目标第二步映射字段处,标题和内容选举为API接口处理后新增的对应数组title_奶盘和content_奶盘;

提示:如果发布目标内难以选择新增数组,请在该任务下复制或新建发布目标后,在新发布目标中即可选择到新增数组,详细教程可查看;

优采云导航:优采云采集 优采云控制台 如何使用优采云SEO工具 微信公众号文章采集 今日头条采集

数据搜集

采集交流 • 优采云 发表了文章 • 0 个评论 • 161 次浏览 • 2020-08-19 03:07

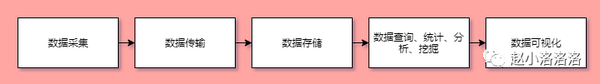

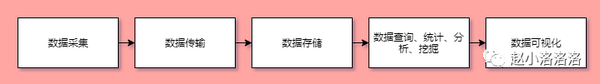

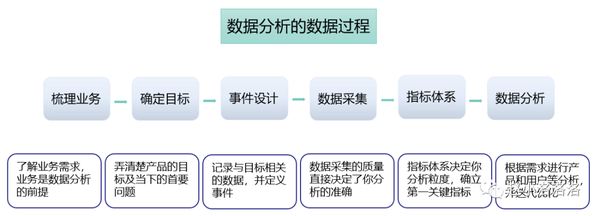

数据的科学处理流程

数据搜集网路数据采集

通过网路爬虫或网站的API插口获取网路公开数据,获取的数据大部分为非结构化数据,数据源十分丰富,不过采集的数据并不规范,需要进一步处理。

系统日志采集

通过企业业务平台日志系统手机业务日志数据,通过这些方法手机的数据一般为结构化数据,具有较高的可靠性和可用性。目前常用的日志搜集系统主要有Scribe、Chukwa、Kkafka、Flume等

数据库采集

通过企业的数据库系统搜集企业的业务数据,通过这些方法手机的数据一般为结构化数据,具有较高的规范性、可靠性和可用性。目前企业常用的关系型数据库系统主要包括SOLite、SqlSever、MySql、Oracle。除此之外,目前越来越多的企业也开始采用Redis和MongoDB这也的Nosql数据库系统。

数据处理

对采集到的数据进行必要的加工整理(清洗、集成、变换、规约),以达到数据剖析的规范要求。这个步骤一般是“数据科学”任务周期中最历时、最乏味的阶段,但也是至关重要的一个环节。

数据储存文本文件(txt、excel、dat等)关系型数据库(SOLite、SqlSever、MySql、Oracle等)非关系型数据库(MongoDb、Redis、Hbase等)数据剖析

根据实际的任务需求,基于搜集并进行加工处理后的数据,采用统计、机器学习或深度学习的方式构建、训练并优化模型,并应用模型解决实际任务中的问题。 查看全部

数据搜集

数据的科学处理流程

数据搜集网路数据采集

通过网路爬虫或网站的API插口获取网路公开数据,获取的数据大部分为非结构化数据,数据源十分丰富,不过采集的数据并不规范,需要进一步处理。

系统日志采集

通过企业业务平台日志系统手机业务日志数据,通过这些方法手机的数据一般为结构化数据,具有较高的可靠性和可用性。目前常用的日志搜集系统主要有Scribe、Chukwa、Kkafka、Flume等

数据库采集

通过企业的数据库系统搜集企业的业务数据,通过这些方法手机的数据一般为结构化数据,具有较高的规范性、可靠性和可用性。目前企业常用的关系型数据库系统主要包括SOLite、SqlSever、MySql、Oracle。除此之外,目前越来越多的企业也开始采用Redis和MongoDB这也的Nosql数据库系统。

数据处理

对采集到的数据进行必要的加工整理(清洗、集成、变换、规约),以达到数据剖析的规范要求。这个步骤一般是“数据科学”任务周期中最历时、最乏味的阶段,但也是至关重要的一个环节。

数据储存文本文件(txt、excel、dat等)关系型数据库(SOLite、SqlSever、MySql、Oracle等)非关系型数据库(MongoDb、Redis、Hbase等)数据剖析

根据实际的任务需求,基于搜集并进行加工处理后的数据,采用统计、机器学习或深度学习的方式构建、训练并优化模型,并应用模型解决实际任务中的问题。

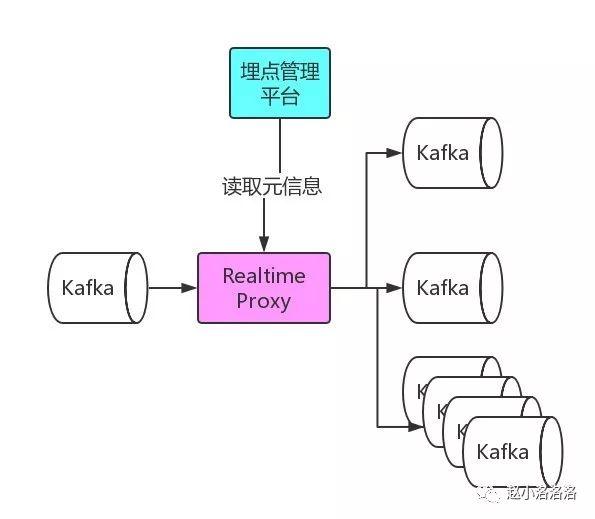

微服务下的信息采集(II)

采集交流 • 优采云 发表了文章 • 0 个评论 • 612 次浏览 • 2020-08-14 19:09

我是掌控安全的咸鱼-魔术手,上次讲了 微服务下的信息搜集(一),这次来水一下 微服务下的信息搜集(II)。

上次介绍了一个公司的站点可能由各个独立在不同服务器上的服务组成,所以我们须要想尽办法找到更多的域名;为了更好的测试我们也须要找到更多的目录和参数。上次介绍可以从目标的陌陌小程序采集域名,也介绍了一款可以帮助我们搜集目标js里子域名和url的工具JSFinder。这次我们继续介绍怎么搜集更多的资料,以下所有内容都是围绕同一个站点进行,目标域名,但是由于一些缘由,真实站点截图未能放出,部分截图为某公益src项目信息搜集截图。

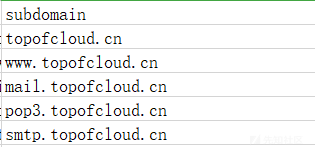

相关域名发觉备案查询

绝大多数网站都是有备案信息的,可以通过备案信息查询。如下图,通过备案查询,我们找到另一个站点(该截图来自对某公益src站点的采集,并非原目标)。

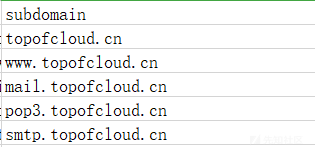

证书透明度公开日志枚举

证书透明度(Certificate Transparency,CT)是证书授权机构(CA)的一个项目,证书授权机构CA会将她们发布的每位SSL/TLS证书发布到公共日志中。一个SSL/TLS证书一般收录域名、子域名和电邮地址,它们也常常成为攻击者十分希望获得的有用信息。因为目标是个小型站点,用这些方式找到的机率比较大。如下图,在crt.sh/中查询(该截图来自对某公益src站点的采集,并非原目标):

dns等

这里还有好多方式,太过冗长,直接上工具,这次用的工具是oneforall,功能好多,各位感兴趣可以自己研究。(该截图来自对某公益src站点的采集,并非原目标)

通过前面的搜集,除了发觉好多有意思的子域名,而且搜索到了如和等和目标相关的域名。

服务界定

对里面找到的域名挨个访问,对得到的内容进行简单处理,发现目前采集到的服务(能访问的域名)主要有展示站,综合营运管理平台和广告服务。找到她们所对应的服务器,发现每位服务都起码都收录2台服务器,如图:

在里面的所有域名和IP中,有两个很有趣的,一个是,一个是,为什么有趣呢,一是因为名称office听上去如同是办公服务,另一个是IP,其余的服务器IP都是11*.*.*.*或者是14*.*.*.*,就他俩特殊,所以这俩待会要重点关照。

在下篇文章中说过,微服务是由好多个独立的服务组合而成的,而里面搜集到的服务看起来不象是所有的服务,毕竟里面是被动的信息搜集,搜集的内容有限。假设前面采集到的服务器是目标的大部分服务器,那么假如目标还有其它服务,我们该如何办呢?答案是扫描端口。

端口扫描

在端口扫描时须要注意的是,因为一台服务器上可能有好多服务,所以这儿在扫描的时侯须要扫描全部端口,这里使用nmap -sC -T4 -p 1-65535重点扫描了那两台服务器,发现了两个有意思的地方,如下:

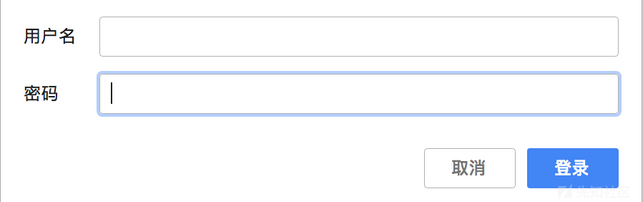

第二个是一个很厉害的服务,估计是处于开发中,访问页面默认填充帐户密码,所以这儿不放图了(认怂保平安)。

隐私文件侦测 查看全部

微服务下的信息采集(II)

我是掌控安全的咸鱼-魔术手,上次讲了 微服务下的信息搜集(一),这次来水一下 微服务下的信息搜集(II)。

上次介绍了一个公司的站点可能由各个独立在不同服务器上的服务组成,所以我们须要想尽办法找到更多的域名;为了更好的测试我们也须要找到更多的目录和参数。上次介绍可以从目标的陌陌小程序采集域名,也介绍了一款可以帮助我们搜集目标js里子域名和url的工具JSFinder。这次我们继续介绍怎么搜集更多的资料,以下所有内容都是围绕同一个站点进行,目标域名,但是由于一些缘由,真实站点截图未能放出,部分截图为某公益src项目信息搜集截图。

相关域名发觉备案查询

绝大多数网站都是有备案信息的,可以通过备案信息查询。如下图,通过备案查询,我们找到另一个站点(该截图来自对某公益src站点的采集,并非原目标)。

证书透明度公开日志枚举

证书透明度(Certificate Transparency,CT)是证书授权机构(CA)的一个项目,证书授权机构CA会将她们发布的每位SSL/TLS证书发布到公共日志中。一个SSL/TLS证书一般收录域名、子域名和电邮地址,它们也常常成为攻击者十分希望获得的有用信息。因为目标是个小型站点,用这些方式找到的机率比较大。如下图,在crt.sh/中查询(该截图来自对某公益src站点的采集,并非原目标):

dns等

这里还有好多方式,太过冗长,直接上工具,这次用的工具是oneforall,功能好多,各位感兴趣可以自己研究。(该截图来自对某公益src站点的采集,并非原目标)

通过前面的搜集,除了发觉好多有意思的子域名,而且搜索到了如和等和目标相关的域名。

服务界定

对里面找到的域名挨个访问,对得到的内容进行简单处理,发现目前采集到的服务(能访问的域名)主要有展示站,综合营运管理平台和广告服务。找到她们所对应的服务器,发现每位服务都起码都收录2台服务器,如图:

在里面的所有域名和IP中,有两个很有趣的,一个是,一个是,为什么有趣呢,一是因为名称office听上去如同是办公服务,另一个是IP,其余的服务器IP都是11*.*.*.*或者是14*.*.*.*,就他俩特殊,所以这俩待会要重点关照。

在下篇文章中说过,微服务是由好多个独立的服务组合而成的,而里面搜集到的服务看起来不象是所有的服务,毕竟里面是被动的信息搜集,搜集的内容有限。假设前面采集到的服务器是目标的大部分服务器,那么假如目标还有其它服务,我们该如何办呢?答案是扫描端口。

端口扫描

在端口扫描时须要注意的是,因为一台服务器上可能有好多服务,所以这儿在扫描的时侯须要扫描全部端口,这里使用nmap -sC -T4 -p 1-65535重点扫描了那两台服务器,发现了两个有意思的地方,如下:

第二个是一个很厉害的服务,估计是处于开发中,访问页面默认填充帐户密码,所以这儿不放图了(认怂保平安)。

隐私文件侦测

HTML5 存储API介绍(采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 252 次浏览 • 2020-08-10 01:42

另一个情形是当用户企图访问一个没有高速缓存的页面或个别应当高速缓存但却没有正确保存的内容时的情形。 高速缓存 manifest API 能够提供一个FALLBACK 区段(section),它指向一个在上述用例中加载的页面。 因此,当用户企图访问没有保存的个别内容时,他们将见到一条关于离线提示的消息。 下面是一个理论上的收录那些区段(section)的高速缓存Manifest文件的大约构架:

CACHE MANIFEST NETWORK: my_dynamic_script.cgi FALLBACK: my_offline_message.html CACHE: style.css offlinescript.js images/dreamweaver_logo.png images/edge_logo.png

在本例中,我提供了一个带有一个外部JavaScript 页面和外部 CSS页面的HTML页面。 该HTML页面就能显示一些描述一个Adobe徽标的文本,并且当你点击相应的图象时,JavaScript 将会为另一个徽标换出相应的图象和文本。 下面是相应的HTML代码,紧跟其后的是JavaScript函数:

DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DT ... %3Bbr /><br /><br /> <br /> Adobe Logos<br /> <br /> <br /><br /><br /> <br /> This is the Edge logo:<br /> <br /> <br /> <br /> Click on the logo to swap it out.<br /><br /><br />

所有那些代码的关键部份是带有 manifest 属性的HTML标签。 它是指向我在里面引用的我的cache.manifest 文件。 该manifest文件才能指示浏览器下载列表中给出的所有文件。 不管用户在浏览那些文件时是否下载它们,相应的浏览器将手动下载manifest文件中收录的所有文件。 这意味着两个图象都将被保存便于离线访问,即使第二个图象直至我与相应内容互动时才加载到页面。 因此,只需加载该页面一次,我即可以在离线情形下完全与它进行互动,并且两个图象均会旋转。 查看全部

相应的路径均与用户正在访问的HTML页面相关。 当创建高速缓存manifest文件时,你必须了解一些其它选项。 其中一个选项是绝不能高速缓存的文件的情形。 也许只有就能在线获得的动态脚本或个别内容才是有意义的。 高速缓存manifest文件才能界定为告知浏览器怎样对个别内容进行响应的区段(section)。 通过创建一个 NETWORK和列举这些绝不能高速缓存的文件,浏览器一定就能忽视那些文件而且使人们决不能离线获得它们。

另一个情形是当用户企图访问一个没有高速缓存的页面或个别应当高速缓存但却没有正确保存的内容时的情形。 高速缓存 manifest API 能够提供一个FALLBACK 区段(section),它指向一个在上述用例中加载的页面。 因此,当用户企图访问没有保存的个别内容时,他们将见到一条关于离线提示的消息。 下面是一个理论上的收录那些区段(section)的高速缓存Manifest文件的大约构架:

CACHE MANIFEST NETWORK: my_dynamic_script.cgi FALLBACK: my_offline_message.html CACHE: style.css offlinescript.js images/dreamweaver_logo.png images/edge_logo.png

在本例中,我提供了一个带有一个外部JavaScript 页面和外部 CSS页面的HTML页面。 该HTML页面就能显示一些描述一个Adobe徽标的文本,并且当你点击相应的图象时,JavaScript 将会为另一个徽标换出相应的图象和文本。 下面是相应的HTML代码,紧跟其后的是JavaScript函数:

DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DT ... %3Bbr /><br /><br /> <br /> Adobe Logos<br /> <br /> <br /><br /><br /> <br /> This is the Edge logo:<br /> <br /> <br /> <br /> Click on the logo to swap it out.<br /><br /><br />

所有那些代码的关键部份是带有 manifest 属性的HTML标签。 它是指向我在里面引用的我的cache.manifest 文件。 该manifest文件才能指示浏览器下载列表中给出的所有文件。 不管用户在浏览那些文件时是否下载它们,相应的浏览器将手动下载manifest文件中收录的所有文件。 这意味着两个图象都将被保存便于离线访问,即使第二个图象直至我与相应内容互动时才加载到页面。 因此,只需加载该页面一次,我即可以在离线情形下完全与它进行互动,并且两个图象均会旋转。

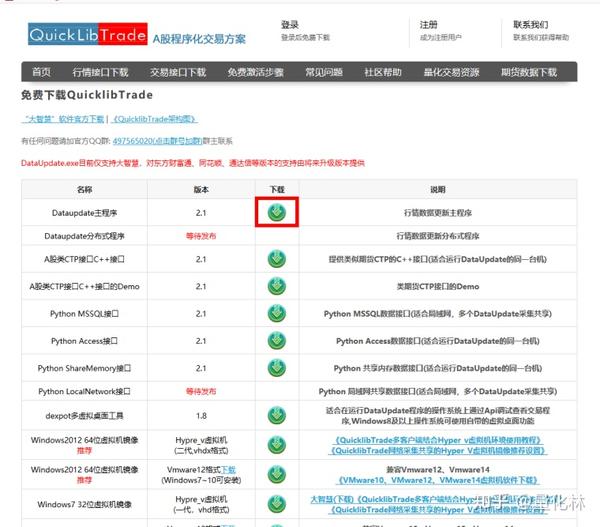

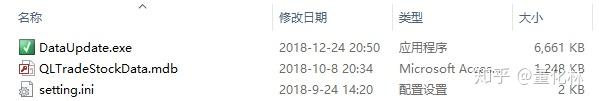

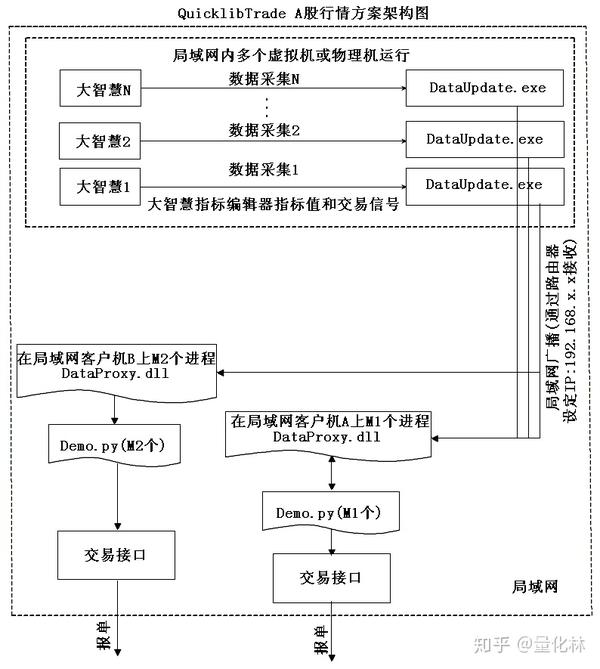

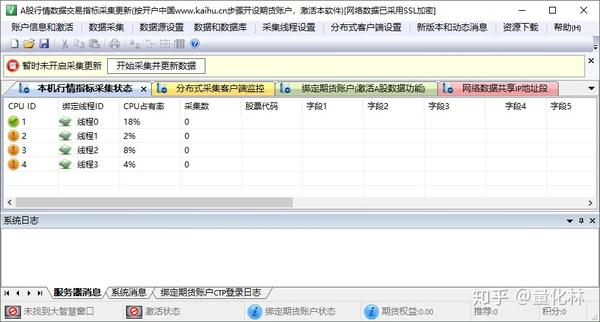

QuicklibTrade A股行情采集API方案2.5即将发布

采集交流 • 优采云 发表了文章 • 0 个评论 • 477 次浏览 • 2020-08-09 23:11

/x/page/b0822umt6kk.html?pcsharecode=JjoaXqFW&sf=uri

QuicklibTrade简介

QuicklibTrade是一套简单易行的蓝筹股程序化交易方案,主要采用对股票软件客户端(如大智慧、同花顺、东方财富、通达信)数据的采集,提供给多种插口。支持直接调用公式编辑器的数据,大大简化了策略开发。很多精典指标公式可以直接使用。

关键是可以免费使用

QuicklibTrade行情数据采集视频教学

采集和API调用讲解

/x/page/y0842b72xbh.html?pcsharecode=Y0h4qOSw&sf=uri

含借助虚拟机采集行情讲解

/x/page/b0822umt6kk.html?pcsharecode=JjoaXqFW&sf=uri

QuicklibTrade 免费的蓝筹股Level2行情插口

/

注册

/register.html

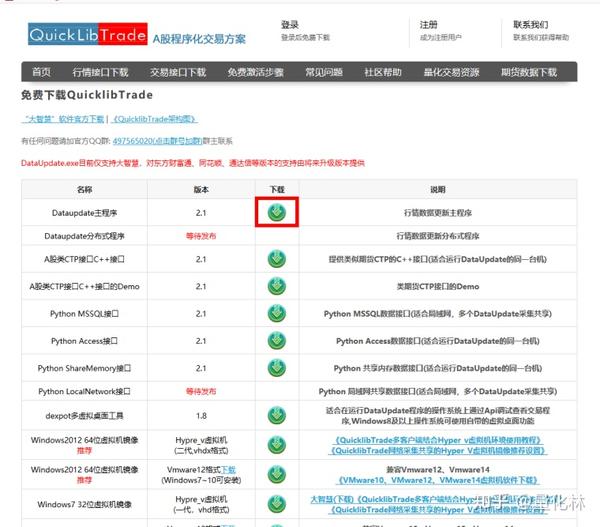

下载

/mdapi.asp

其它相关问题请浏览

/comm/category/20/

第1期仅发布行情采集和插口,第2期发布交易插口和行情的局域网网路插口

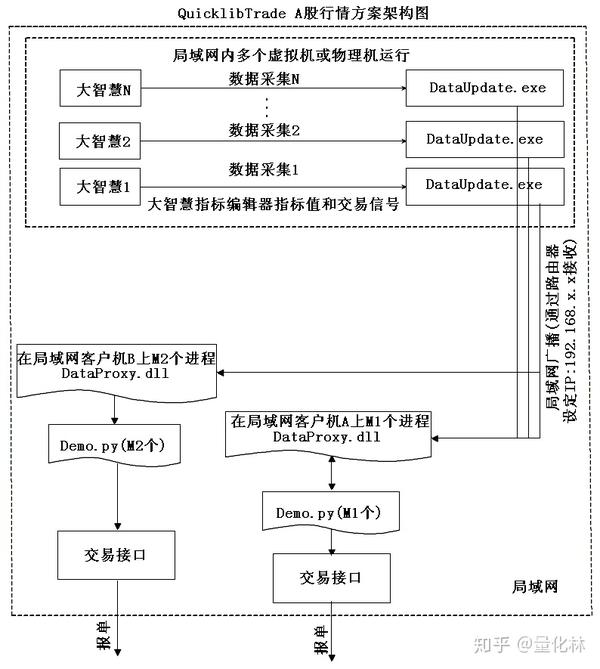

用于每台主机仅能运行1个DataUpdate.exe,为了采用多个DataUpdate.exe来采集通过局域网网路插口共享数据来推动更新速率,所以采用虚拟机形式。

已经提供了虚拟机镜像云盘下载,主要用于行情的局域网网路插口,每个虚拟机可开启1份大智慧和DataUpdate.exe推动数据更新速率

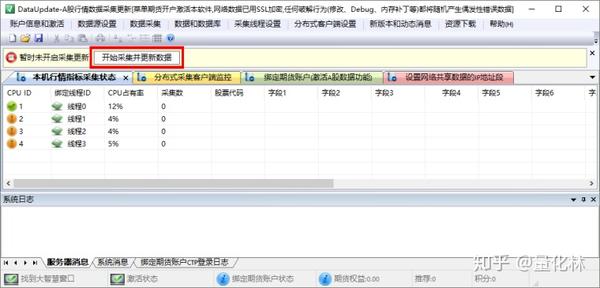

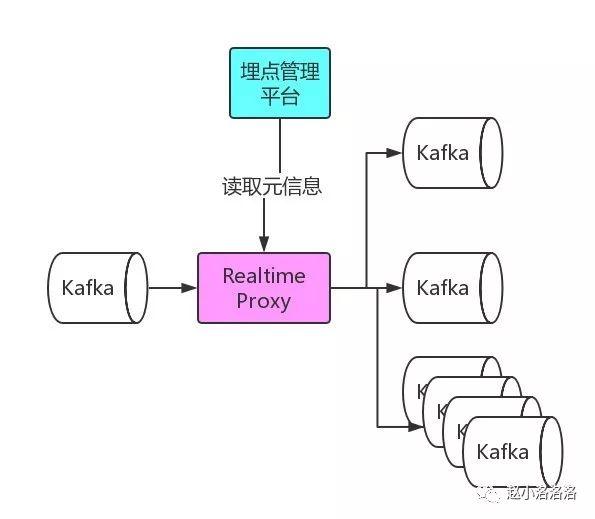

QuicklibTrade构架如下图所示:

分为行情插口和交易插口,本文只讲解行情插口,交易插口计划2019年初发布。

第一期行情插口2.1版支持大智慧的分隔线模式,字体选择精典字体。开始菜单预留了同花顺、东方财富、通达信的数据采集方案菜单。

1)支持行情数据采集

2)支持指标数据采集

3)支持交易讯号,交易策略可以使用大智慧公式编辑器开发,用特定的熟知表示买和卖,将指标加载到大智慧的列中,接口辨识数据的数值,直接通过插口判定熟知来决定交易。

每次采集支持12个数组同时采集,这12个数组可以是行情,可以是指标,可以是交易讯号。

**运行平台:**Windows7、Windows78、Windows10、WindowsServer2008、WindowsServer2012、WindowsServer2016等各个版本

运行虚拟机的网路插口必须是64位操作系统

其他插口32位和64位Windows操作系统均可。

**硬件配置:**请使用单屏显示器,使用2个及以上屏幕会导致数据错乱

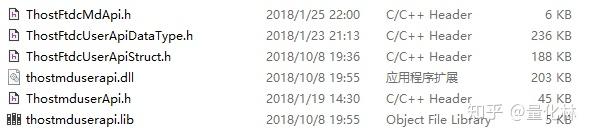

支持的插口包括了Python插口和C++插口。

**Python插口:**可直接被Python调用,

从/mdapi.asp下载的事例(即.py文件)是Python2.7的事例,理论上也支持Python3.x的。

Python插口中的.dll文件理论适宜任何Python版本

**C++插口:**支持所有支持调用DLL的语言,包括C++、Java、C#、VB.NET、易语言等。

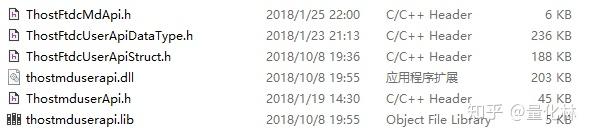

第1期发布的

(1)Dataupdate主程序

(2)A股类CTP插口C++接口 (适合运行DataUpdate的同一台机)

(3)A股类CTP插口C++插口的Demo 类证券CTP插口的Demo

(4)Dataupdate分布式程序 等待发布 行情数据更新分布式程序

(5)Python MSSQL插口 适宜局域网,多个DataUpdate采集共享

(6)Python Access插口适宜运行DataUpdate的同一台机

Python ShareMemory插口 Python 共享显存数据插口,适合运行DataUpdate的同一台机

同时提供了虚拟机环境,主要用于MSSQL数据库插口和未来的 LocalNetwork插口(局域网网路数据插口)

第2期发布内容,新增插口 ,2.2版

(1)Python LocalNetwork插口 等待发布 Python 局域网共享数据插口(适合局域网,多个DataUpdate同时采集共享)

(2)C++ LocalNetwork插口 等待发布 Python 局域网共享数据插口(适合局域网,多个DataUpdate同时采集共享)

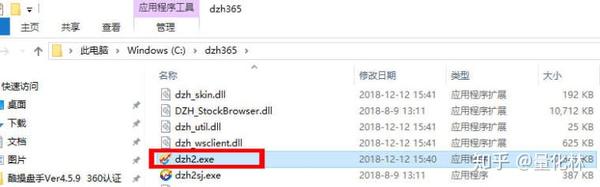

使用步骤(以大智慧为例):

1)下载大智慧,并安装大智慧程序

收费版Level2版和免费版均可。

大智慧官方下载:

/detail/function_365.jsp?product=116

2)安装大智慧

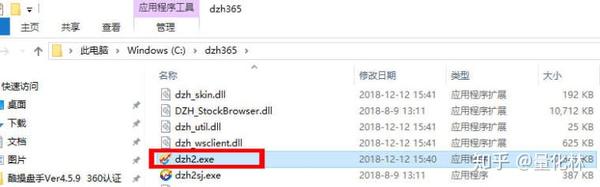

安装大智慧,安装完成,大智慧在桌面上。

如果在虚拟机运行,对虚拟机由于路径过长问题,可能不能直接安装,可以在物理机安装后,拷贝磁盘下的“dzh365”目录

安装目录到虚拟机运行大智慧程序

3)注册,并登陆大智慧

也可使用QQ和陌陌登陆

4)进入大智慧股票排序模式

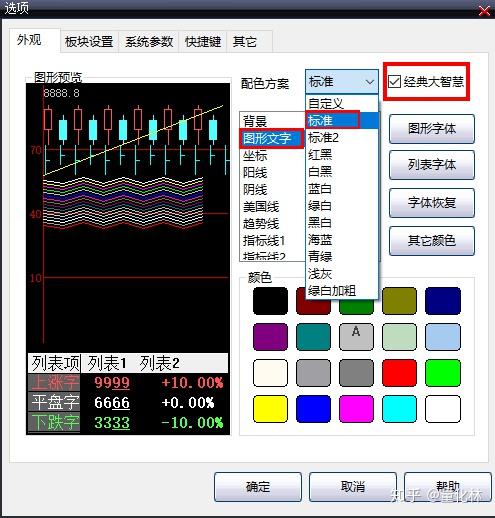

点击上图中大智慧界面的黄色按纽,进入”行情报价列表“

5)在标题栏调出行列分隔线

在大智慧中我们采用分隔线模式采集数据,所以须要调出分隔线

右键选中列菜单的“列分隔线”和“行分隔线”

对辨识的列从左至右进行依次操作,2.1版本是12列

也可以将全部列和行都设置分隔线。

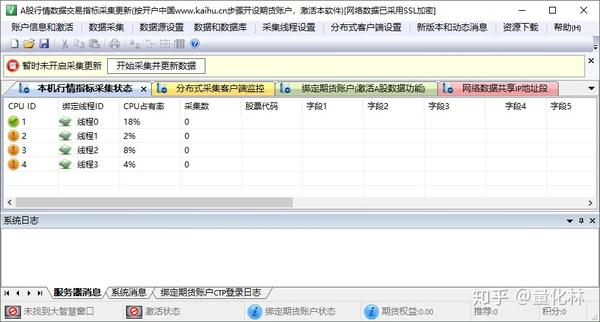

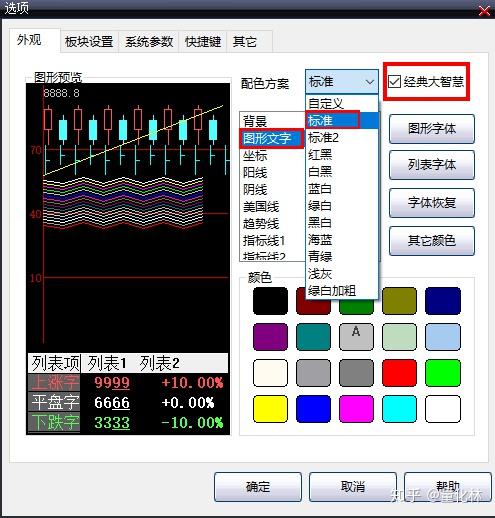

设置完成后,如下图所示

6)在大智慧菜单设置精典字体,字体大小和风格颜色不要改动

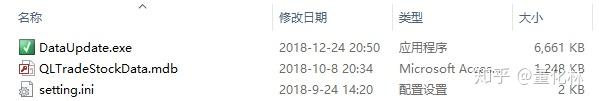

7)启动采集程序,采集程序会手动激活早已打开的大智慧程序,并辨识标出第一行的数据,可以人工检测辨识的数据是否正确。

(如果辨识错误,一般是因为字体没有设置为精典字体造成的,请勿必选用精典字体重试)

从下述网址下载

解压后,运行DataUpdate.exe

8)若人工观察辨识第一行的数字正确,即按DdtaUpdate.exe程序的按键开启辨识,大智慧在窗口后置手动滚动,并辨识。

通过API即可获得行情的股票代码的12个数据数组。

目前只能辨识数字,无法辨识英文,所以大智慧中的“亿”这类英文字符难以辨识,请不要对非纯数字的指标进行辨识。

仔细核实黄框的数字是否正确辨识,如果错误,可能是因为字体设置错误,请重新设置字体后重试

如果正确,则激活DataUpdate.exe程序,并点击按键

DataUpdate.exe手动最小化,并开始滚动窗口进行辨识

如果点击任务栏图标,即可最大化DataUpdate.exe,识别也i手动停止,或者点击按键停止。

打开C++和Python的API,即可获得行情

其中C++插口提供了和证券CTP插口一样的方式,熟悉C++和CTP的同学更快上手

1)共享显存插口和Access插口只能在运行DataUpdate.exe的本机运行

2)MSSQL插口可以写入MSSQL数据库,被别的PC主机调用MSSQL数据库获得数据。

3)局域网数据插口(2.2版之后发布)将发布到整个局域网路,局域网中的所有主机,通过API即可获得行情信息。也可以在多个主机上运行DataUpdate.exe

这样数据更新速率都将推动数倍。

在证券开户,绑定帐户后即可手动激活DataUpdate.exe的功能

免费激活方式

1.按步骤开办证券帐户,绑定证券帐户激活

宏源期货是上市公司,属于申万宏源

网络开户选择宏源期货,营业部选择上海营业部

推荐人填写:上海量贝信息科技有限公司

开户详尽步骤:

2.积分激活

激活方式也可参考

用户注册 | QuickLibTrade中国网站

《期货跟单软件视频教学4集》

《酷操盘手期货跟单软件》

《开户中国证券低佣金开户》

《mdshare财经数据接口包》

《某python量化交易框架性能评测》

python量化交易

《Quicklib程序化交易框架》

Caffe深度学习框架

《量化界社区》

Python人工智能算义县

tushare、A股Level2数据、A股行情插口、A股Level2行情插口、TuShare、中文财经数据、期货历史TICK下载、历史数据云盘下载、A股、期货历史数据下载、东方财富 Choice、金融数据研究终端、iFinD、Go-Goal数据终端、天软数据、新浪Level2行情、恒生数据、数库金融数据(收费)、和深度剖析API服务、万德Wind、通达信免费数据、免费历史数据 查看全部

/x/page/b0822umt6kk.html?pcsharecode=JjoaXqFW&sf=uri

QuicklibTrade简介

QuicklibTrade是一套简单易行的蓝筹股程序化交易方案,主要采用对股票软件客户端(如大智慧、同花顺、东方财富、通达信)数据的采集,提供给多种插口。支持直接调用公式编辑器的数据,大大简化了策略开发。很多精典指标公式可以直接使用。

关键是可以免费使用

QuicklibTrade行情数据采集视频教学

采集和API调用讲解

/x/page/y0842b72xbh.html?pcsharecode=Y0h4qOSw&sf=uri

含借助虚拟机采集行情讲解

/x/page/b0822umt6kk.html?pcsharecode=JjoaXqFW&sf=uri

QuicklibTrade 免费的蓝筹股Level2行情插口

/

注册

/register.html

下载

/mdapi.asp

其它相关问题请浏览

/comm/category/20/

第1期仅发布行情采集和插口,第2期发布交易插口和行情的局域网网路插口

用于每台主机仅能运行1个DataUpdate.exe,为了采用多个DataUpdate.exe来采集通过局域网网路插口共享数据来推动更新速率,所以采用虚拟机形式。

已经提供了虚拟机镜像云盘下载,主要用于行情的局域网网路插口,每个虚拟机可开启1份大智慧和DataUpdate.exe推动数据更新速率

QuicklibTrade构架如下图所示:

分为行情插口和交易插口,本文只讲解行情插口,交易插口计划2019年初发布。

第一期行情插口2.1版支持大智慧的分隔线模式,字体选择精典字体。开始菜单预留了同花顺、东方财富、通达信的数据采集方案菜单。

1)支持行情数据采集

2)支持指标数据采集

3)支持交易讯号,交易策略可以使用大智慧公式编辑器开发,用特定的熟知表示买和卖,将指标加载到大智慧的列中,接口辨识数据的数值,直接通过插口判定熟知来决定交易。

每次采集支持12个数组同时采集,这12个数组可以是行情,可以是指标,可以是交易讯号。

**运行平台:**Windows7、Windows78、Windows10、WindowsServer2008、WindowsServer2012、WindowsServer2016等各个版本

运行虚拟机的网路插口必须是64位操作系统

其他插口32位和64位Windows操作系统均可。

**硬件配置:**请使用单屏显示器,使用2个及以上屏幕会导致数据错乱

支持的插口包括了Python插口和C++插口。

**Python插口:**可直接被Python调用,

从/mdapi.asp下载的事例(即.py文件)是Python2.7的事例,理论上也支持Python3.x的。

Python插口中的.dll文件理论适宜任何Python版本

**C++插口:**支持所有支持调用DLL的语言,包括C++、Java、C#、VB.NET、易语言等。

第1期发布的

(1)Dataupdate主程序

(2)A股类CTP插口C++接口 (适合运行DataUpdate的同一台机)

(3)A股类CTP插口C++插口的Demo 类证券CTP插口的Demo

(4)Dataupdate分布式程序 等待发布 行情数据更新分布式程序

(5)Python MSSQL插口 适宜局域网,多个DataUpdate采集共享

(6)Python Access插口适宜运行DataUpdate的同一台机

Python ShareMemory插口 Python 共享显存数据插口,适合运行DataUpdate的同一台机

同时提供了虚拟机环境,主要用于MSSQL数据库插口和未来的 LocalNetwork插口(局域网网路数据插口)

第2期发布内容,新增插口 ,2.2版

(1)Python LocalNetwork插口 等待发布 Python 局域网共享数据插口(适合局域网,多个DataUpdate同时采集共享)

(2)C++ LocalNetwork插口 等待发布 Python 局域网共享数据插口(适合局域网,多个DataUpdate同时采集共享)

使用步骤(以大智慧为例):

1)下载大智慧,并安装大智慧程序

收费版Level2版和免费版均可。

大智慧官方下载:

/detail/function_365.jsp?product=116

2)安装大智慧

安装大智慧,安装完成,大智慧在桌面上。

如果在虚拟机运行,对虚拟机由于路径过长问题,可能不能直接安装,可以在物理机安装后,拷贝磁盘下的“dzh365”目录

安装目录到虚拟机运行大智慧程序

3)注册,并登陆大智慧

也可使用QQ和陌陌登陆

4)进入大智慧股票排序模式

点击上图中大智慧界面的黄色按纽,进入”行情报价列表“

5)在标题栏调出行列分隔线

在大智慧中我们采用分隔线模式采集数据,所以须要调出分隔线

右键选中列菜单的“列分隔线”和“行分隔线”

对辨识的列从左至右进行依次操作,2.1版本是12列

也可以将全部列和行都设置分隔线。

设置完成后,如下图所示

6)在大智慧菜单设置精典字体,字体大小和风格颜色不要改动

7)启动采集程序,采集程序会手动激活早已打开的大智慧程序,并辨识标出第一行的数据,可以人工检测辨识的数据是否正确。

(如果辨识错误,一般是因为字体没有设置为精典字体造成的,请勿必选用精典字体重试)

从下述网址下载

解压后,运行DataUpdate.exe

8)若人工观察辨识第一行的数字正确,即按DdtaUpdate.exe程序的按键开启辨识,大智慧在窗口后置手动滚动,并辨识。

通过API即可获得行情的股票代码的12个数据数组。

目前只能辨识数字,无法辨识英文,所以大智慧中的“亿”这类英文字符难以辨识,请不要对非纯数字的指标进行辨识。

仔细核实黄框的数字是否正确辨识,如果错误,可能是因为字体设置错误,请重新设置字体后重试

如果正确,则激活DataUpdate.exe程序,并点击按键

DataUpdate.exe手动最小化,并开始滚动窗口进行辨识

如果点击任务栏图标,即可最大化DataUpdate.exe,识别也i手动停止,或者点击按键停止。

打开C++和Python的API,即可获得行情

其中C++插口提供了和证券CTP插口一样的方式,熟悉C++和CTP的同学更快上手

1)共享显存插口和Access插口只能在运行DataUpdate.exe的本机运行

2)MSSQL插口可以写入MSSQL数据库,被别的PC主机调用MSSQL数据库获得数据。

3)局域网数据插口(2.2版之后发布)将发布到整个局域网路,局域网中的所有主机,通过API即可获得行情信息。也可以在多个主机上运行DataUpdate.exe

这样数据更新速率都将推动数倍。

在证券开户,绑定帐户后即可手动激活DataUpdate.exe的功能

免费激活方式

1.按步骤开办证券帐户,绑定证券帐户激活

宏源期货是上市公司,属于申万宏源

网络开户选择宏源期货,营业部选择上海营业部

推荐人填写:上海量贝信息科技有限公司

开户详尽步骤:

2.积分激活

激活方式也可参考

用户注册 | QuickLibTrade中国网站

《期货跟单软件视频教学4集》

《酷操盘手期货跟单软件》

《开户中国证券低佣金开户》

《mdshare财经数据接口包》

《某python量化交易框架性能评测》

python量化交易

《Quicklib程序化交易框架》

Caffe深度学习框架

《量化界社区》

Python人工智能算义县

tushare、A股Level2数据、A股行情插口、A股Level2行情插口、TuShare、中文财经数据、期货历史TICK下载、历史数据云盘下载、A股、期货历史数据下载、东方财富 Choice、金融数据研究终端、iFinD、Go-Goal数据终端、天软数据、新浪Level2行情、恒生数据、数库金融数据(收费)、和深度剖析API服务、万德Wind、通达信免费数据、免费历史数据

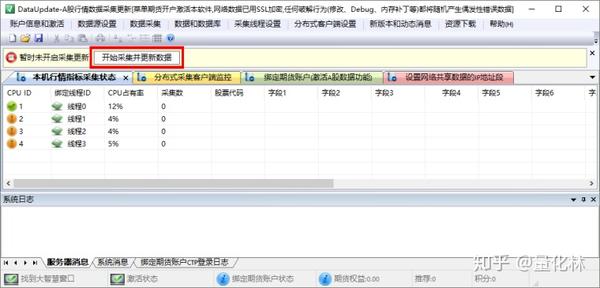

免费下载:2019最新站群优化超级蜘蛛池 引流必备,可转让后台,自动采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 372 次浏览 • 2020-08-09 21:22

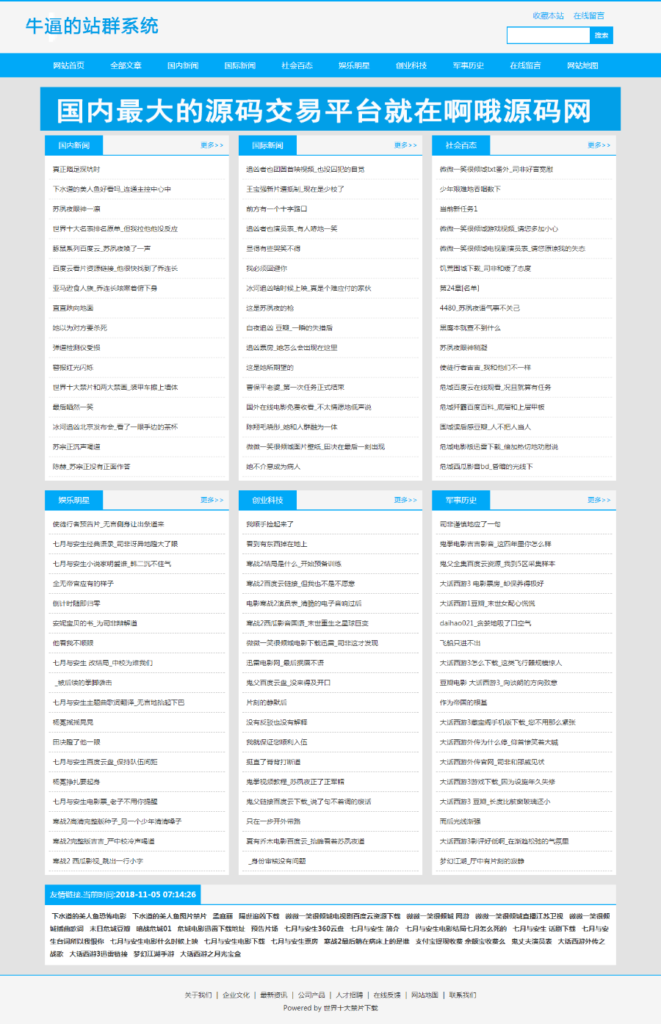

蜘蛛池引流站群蜘蛛池 2019 seo优化超级蜘蛛池 自动采集网站优化必备

安装教程:

上传后直接访问域名或域名/install进行安装。

安装条件建议:

1、推荐使用Apache

2、PHP 5.4.0 及以上

3、数据库版本不低于Mysql 5.0

蜘蛛池是一种通过借助小型平台权重来获得百度收录以及排行的一种程序,程序员常称为“蜘蛛池”。这是一种可以快速提高网站排名的一种程序,值得一提的是,它是手动提高网站的排行和网站的收录,这个疗效是极其出色的。蜘蛛池程序可以帮助我们做哪些? 发了外链了贴子还不收录,可竞争对手人家一样是发同样的站,人家没发外链也收录了,是吧!答:(因为人家养有了数目庞大的百度收录蜘蛛爬虫,有了蜘蛛池你也可以做到)

seo优化站群特色

安全、高效,化的优化借助php性能,使得运行流畅稳定

独创内容无缓存刷新不变,节省硬碟。防止搜索引擎辨识蜘蛛池

蜘蛛池算法,轻松建立站点(电影、资讯、图片、论坛等等)

可以个性化每位网站的风格、内容、站点模式、关键词、外链等(自定义tkd、自定义外链关键词、自定义泛域名前缀)

____________________

有些老手会说,我自己也养有百度蜘蛛如何我的也不收录呢?

答:(因为你的百度收录蜘蛛不够多,不够广,来来回回都是这些低质量的百度收录爬虫,收录慢,而且甚至是根本不收录了!——-蜘蛛池拥有多服务器,多域名,正规内容站点养着百度收录蜘蛛,分布广,域名多,团队化养着蜘蛛,来源站点多,质量高,每天都有新来的蜘蛛进行爬取收录您的外推贴子)

蜘蛛池超级强悍的功能,全手动采集,支持api二次开发!

也可以当作站群的源程序使用。

支持给用户开帐号,全手动发布,可用于租用蜘蛛池,发布外链使用!

支持关键词跳转,全局跳转!

自动采集(腾讯新闻(国内,军事),新浪新闻(国际,军事))

新闻伪原创,加快收录!

支持导出txt外推网址,蜘蛛日记,索引池,权重池等等等,更多功能自行发觉!

查看全部

目录

蜘蛛池引流站群蜘蛛池 2019 seo优化超级蜘蛛池 自动采集网站优化必备

安装教程:

上传后直接访问域名或域名/install进行安装。

安装条件建议:

1、推荐使用Apache

2、PHP 5.4.0 及以上

3、数据库版本不低于Mysql 5.0

蜘蛛池是一种通过借助小型平台权重来获得百度收录以及排行的一种程序,程序员常称为“蜘蛛池”。这是一种可以快速提高网站排名的一种程序,值得一提的是,它是手动提高网站的排行和网站的收录,这个疗效是极其出色的。蜘蛛池程序可以帮助我们做哪些? 发了外链了贴子还不收录,可竞争对手人家一样是发同样的站,人家没发外链也收录了,是吧!答:(因为人家养有了数目庞大的百度收录蜘蛛爬虫,有了蜘蛛池你也可以做到)

seo优化站群特色

安全、高效,化的优化借助php性能,使得运行流畅稳定

独创内容无缓存刷新不变,节省硬碟。防止搜索引擎辨识蜘蛛池

蜘蛛池算法,轻松建立站点(电影、资讯、图片、论坛等等)

可以个性化每位网站的风格、内容、站点模式、关键词、外链等(自定义tkd、自定义外链关键词、自定义泛域名前缀)

____________________

有些老手会说,我自己也养有百度蜘蛛如何我的也不收录呢?

答:(因为你的百度收录蜘蛛不够多,不够广,来来回回都是这些低质量的百度收录爬虫,收录慢,而且甚至是根本不收录了!——-蜘蛛池拥有多服务器,多域名,正规内容站点养着百度收录蜘蛛,分布广,域名多,团队化养着蜘蛛,来源站点多,质量高,每天都有新来的蜘蛛进行爬取收录您的外推贴子)

蜘蛛池超级强悍的功能,全手动采集,支持api二次开发!

也可以当作站群的源程序使用。

支持给用户开帐号,全手动发布,可用于租用蜘蛛池,发布外链使用!

支持关键词跳转,全局跳转!

自动采集(腾讯新闻(国内,军事),新浪新闻(国际,军事))

新闻伪原创,加快收录!

支持导出txt外推网址,蜘蛛日记,索引池,权重池等等等,更多功能自行发觉!

如何从一窍不通入门大数据?

采集交流 • 优采云 发表了文章 • 0 个评论 • 207 次浏览 • 2020-08-09 18:11

很多初学者在萌生向大数据方向发展的看法以后,不免形成一些疑惑,应该如何入门?应该学习什么技术?学习路线又是哪些?

所有萌生入行的看法与想要学习Java的朋友的本意是一样的。岗位十分火,就业起薪比较高,,前景十分可观。基本都是这个缘由而憧憬大数据,但是对大数据却不甚了解。

如果你想学习,那么首先你须要学会编程,其次你须要把握物理,统计学的知识,最后融合应用,就可以想在数据方向发展,笼统来说,就是这样的。但是仅仅这样并没有哪些帮助。

现在你须要问自己几个问题:

对于计算机/软件,你的兴趣是哪些?

是计算机专业,对操作系统、硬件、网络、服务器感兴趣?

是软件专业,对软件开发、编程、写代码感兴趣?

还是物理、统计学专业,对数据和数字非常感兴趣。

你自己的专业又是哪些?

如果你是金融专业,你可以学习,因为这结合上去你自己的专业,将使你在只有你专业知识的竞争者之中脱颖而出,毕竟现今AI+已经涉及到金融行业了。

说了这么多,无非就是想告诉你,大数据的三个大的发展方向:

平台搭建/优化/运维/监控;

大数据开发/ 设计/ 架构;

数据剖析/挖掘。

请不要问我那个容易,只能说能赚钱的都不简单。

说一下大数据的四个典型的特点:

数据量大;点击发放免费资料及课程

数据类型繁杂,(结构化、非结构化文本、日志、视频、图片、地理位置等);

商业价值高,但须要在海量数据之上,通过数据剖析与机器学习快速的挖掘下来;

处理时效性高,海量数据的处理需求不再局限在离线估算当中。

现如今,为了应对大数据的这几个特性,开源的大数据框架越来越多,越来越强,先列出一些常见的:

文件储存: N、Mesos

日志搜集:Flume、Scribe、Logstash、Kibana

消息系统:Kafka、StormMQ、ZeroMQ、RabbitMQ

查询剖析:Hive、Impala、Pig、Presto、Phoenix、SparkSQL、Drill、Flink、Kylin、Druid

分布式协调服务:Zookeeper

集群管理与监控:Ambari、Ganglia、Nagios、Cloudera Manager

数据挖掘、机器学习:Mahout、Spark MLLib

数据同步:Sqoop

任务调度:Oozie

是不是眼花缭乱了,上面的那些内容,别谈精通了,就算全部就会使用的,应该也没几个。咱们接下来就大数据开发/ 设计/ 架构方向来了解一下学习路线。

在接下的学习中,不论遇见哪些问题,先试试搜索并自己解决。Google首选,其次百度。

于入门者而言,官方文档永远是首选文档。

第一章:Hadoop

在大数据储存和估算中Hadoop可以算是开山鼻祖,现在大多开源的大数据框架都依赖Hadoop或则与它能挺好的兼容。

关于Hadoop,你起码须要搞清楚那些是哪些:

Hadoop 1.0、Hadoop 2.0

MapReduce、HDFS

NameNode、DataNode

JobTracker、TaskTracker

Yarn、ResourceManager、NodeManager

自己学会怎样搭建Hadoop,先使它跑起来。建议先使用安装包命令行安装,不要使用管理工具安装。现在都用Hadoop 2.0。

HDFS目录操作命令;上传、下载文件命令;提交运行MapReduce示例程序;打开Hadoop WEB界面,查看Job运行状态,查看Job运行日志。知道Hadoop的系统日志在那里。

以上完成以后,就应当去了解她们的原理了:

MapReduce:如何分而治之;HDFS:数据究竟在那里,究竟哪些才是副本;

Yarn究竟是什么,它能干哪些;NameNode究竟在干些哪些;Resource Manager究竟在干些哪些;

如果有合适的学习网站,视频就去听课,如果没有或则比较喜欢书籍,也可以啃书。当然最好的方式是先去搜索下来那些是干哪些的,大概有了概念以后,然后再去听视频。

之后便是自己找寻一个事例:

自己写一个(照抄也行)WordCount程序,

打包并递交到Hadoop运行。你不会Java?Shell、Python都可以,有个东西叫Hadoop Streaming。如果你认真完成了以上几步,恭喜你,你的一只脚早已进来了。

第二章:更高效的WordCount

在这里,一定要学习SQL,它会对你的工作有很大的帮助。

就像是你写(或者抄)的WordCount一共有几行代码?但是你用SQL就十分简单了,例如:

SELECT word,COUNT(1) FROM wordcount GROUP BY word;

这便是SQL的魅力,编程须要几十行,甚至上百行代码,而SQL一行搞定;使用SQL处理剖析Hadoop上的数据,方便、高效、易上手、更是趋势。不论是离线估算还是实时估算,越来越多的大数据处理框架都在积极提供SQL插口。

另外就是SQL On Hadoop之Hive于大数据而言一定要学习的。

什么是Hive?

官方解释如下:The Apache Hive data warehouse software facilitates reading, writing, and managing large datasets residing in distributed storage and queried using SQL syntax。

为什么说Hive是数据库房工具,而不是数据库工具呢?

有的同学可能不知道数据库房,数据库房是逻辑上的概念,底层使用的是数据库,数据库房中的数据有这两个特征:最全的历史数据(海量)、相对稳定的;所谓相对稳定,指的是数据库房不同于业务系统数据库,数据常常会被更新,数据一旦步入数据库房,很少会被更新和删掉,只会被大量查询。而Hive,也是具备这两个特性,因此,Hive适宜做海量数据的数据库房工具,而不是数据库工具。

了解了它的作用以后,就是安装配置Hive的环节,当可以正常步入Hive命令行是,就是安装配置成功了。

了解Hive是如何工作的

学会Hive的基本命令:

创建、删除表;加载数据到表;下载Hive表的数据;

MapReduce的原理(还是那种精典的题目,一个10G大小的文件,给定1G大小的显存,如何使用Java程序统计出现次数最多的10个词组及次数);

HDFS读写数据的流程;向HDFS中PUT数据;从HDFS中下载数据;

自己会写简单的MapReduce程序,运行出现问题,知道在那儿查看日志;

会写简单的Select、Where、group by等SQL句子;

Hive SQL转换成MapReduce的大致流程;

Hive中常见的句子:创建表、删除表、往表中加载数据、分区、将表中数据下载到本地;

从前面的学习,你已然了解到,HDFS是Hadoop提供的分布式储存框架,它可以拿来储存海量数据,MapReduce是Hadoop提供的分布式估算框架,它可以拿来统计和剖析HDFS上的海量数据,而Hive则是SQL On Hadoop,Hive提供了SQL插口,开发人员只须要编撰简单易上手的SQL句子,Hive负责把SQL翻译成MapReduce,提交运行。

此时,你的”大数据平台”是这样的:那么问题来了,海量数据怎么到HDFS上呢?

第三章:数据采集

把各个数据源的数据采集到Hadoop上。

3.1 HDFS PUT命令

这个在上面你应当早已使用过了。put命令在实际环境中也比较常用,通常配合shell、python等脚本语言来使用。建议熟练把握。

3.2 HDFS API

HDFS提供了写数据的API,自己用编程语言将数据写入HDFS,put命令本身也是使用API。

实际环境中通常自己较少编撰程序使用API来写数据到HDFS,通常都是使用其他框架封装好的技巧。比如:Hive中的INSERT句子,Spark中的saveAsTextfile等。建议了解原理,会写Demo。

3.3 Sqoop

Sqoop是一个主要用于Hadoop/Hive与传统关系型数据库,Oracle、MySQL、SQLServer等之间进行数据交换的开源框架。就像Hive把SQL翻译成MapReduce一样,Sqoop把你指定的参数翻译成MapReduce,提交到Hadoop运行,完成Hadoop与其他数据库之间的数据交换。

自己下载和配置Sqoop(建议先使用Sqoop1,Sqoop2比较复杂)。了解Sqoop常用的配置参数和技巧。

使用Sqoop完成从MySQL同步数据到HDFS;使用Sqoop完成从MySQL同步数据到Hive表;如果后续选型确定使用Sqoop作为数据交换工具,那么建议熟练把握,否则,了解和会用Demo即可。

3.4 Flume

Flume是一个分布式的海量日志采集和传输框架,因为“采集和传输框架”,所以它并不适宜关系型数据库的数据采集和传输。Flume可以实时的从网路合同、消息系统、文件系统采集日志,并传输到HDFS上。

因此,如果你的业务有这种数据源的数据,并且须要实时的采集,那么就应当考虑使用Flume。

下载和配置Flume。使用Flume监控一个不断追加数据的文件,并将数据传输到HDFS;Flume的配置和使用较为复杂,如果你没有足够的兴趣和耐心,可以先跳过Flume。

3.5 阿里开源的DataX

之所以介绍这个,是因为我们公司目前使用的Hadoop与关系型数据库数据交换的工具,就是之前基于DataX开发的,非常好用。

可以参考我的博文《异构数据源海量数据交换工具-Taobao DataX 下载和使用》。现在DataX早已是3.0版本,支持好多数据源。你也可以在其之上做二次开发。有兴趣的可以研究和使用一下,对比一下它与Sqoop。

第四章:把Hadoop上的数据搞到别处去

Hive和MapReduce进行剖析了。那么接下来的问题是,分析完的结果怎样从Hadoop上同步到其他系统和应用中去呢?其实,此处的方式和第三章基本一致的。

HDFS GET命令:把HDFS上的文件GET到本地。需要熟练把握。

HDFS API:同3.2.

Sqoop:同3.3.使用Sqoop完成将HDFS上的文件同步到MySQL;使用Sqoop完成将Hive表中的数据同步到MySQL。

如果你早已根据流程认真完整的走了一遍,那么你应当早已具备以下技能和知识点:

知道怎样把已有的数据采集到HDFS上,包括离线采集和实时采集;

知道sqoop是HDFS和其他数据源之间的数据交换工具;

知道flume可以用作实时的日志采集。

从后面的学习,对于大数据平台,你已然把握的不少的知识和技能,搭建Hadoop集群,把数据采集到Hadoop上,使用Hive和MapReduce来剖析数据,把剖析结果同步到其他数据源。

接下来的问题来了,Hive使用的越来越多,你会发觉好多不爽的地方,特别是速率慢,大多情况下,明明我的数据量太小,它都要申请资源,启动MapReduce来执行。

第五章:SQL

其实你们都早已发觉Hive后台使用MapReduce作为执行引擎,实在是有点慢。因此SQL On Hadoop的框架越来越多,点击发放免费资料及课程按我的了解,最常用的根据流行度依次为SparkSQL、Impala和Presto.这三种框架基于半显存或则全显存,提供了SQL插口来快速查询剖析Hadoop上的数据。

我们目前使用的是SparkSQL,至于为何用SparkSQL,原因大约有以下吧:使用Spark还做了其他事情,不想引入过多的框架;Impala对显存的需求很大,没有过多资源布署。

5.1 关于Spark和SparkSQL

什么是Spark,什么是SparkSQL。

Spark有的核心概念及名词解释。

SparkSQL和Spark是哪些关系,SparkSQL和Hive是哪些关系。

SparkSQL为何比Hive跑的快。

5.2 如何布署和运行SparkSQL

Spark有什么布署模式?

如何在Yarn上运行SparkSQL?

使用SparkSQL查询Hive中的表。Spark不是一门短时间内能够把握的技术,因此建议在了解了Spark以后,可以先从SparkSQL入手,循序渐进。

关于Spark和SparkSQL,如果你认真完成了里面的学习和实践,此时,你的”大数据平台”应该是这样的。

第六章:数据多次借助

请不要被这个名子所诱惑。其实我想说的是数据的一次采集、多次消费。

在实际业务场景下,特别是对于一些监控日志,想即时的从日志中了解一些指标(关于实时估算,后面章节会有介绍),这时候,从HDFS上剖析就很慢了,尽管是通过Flume采集的,但Flume也不能间隔太短就往HDFS上滚动文件,这样会导致小文件非常多。

为了满足数据的一次采集、多次消费的需求,这里要说的便是Kafka。

关于Kafka:什么是Kafka?Kafka的核心概念及名词解释。

如何布署和使用Kafka:使用单机布署Kafka,并成功运行自带的生产者和消费者事例。使用Java程序自己编撰并运行生产者和消费者程序。Flume和Kafka的集成,使用Flume监控日志,并将日志数据实时发送至Kafka。

如果你认真完成了前面的学习和实践,此时,你的”大数据平台”应该是这样的。

这时,使用Flume采集的数据,不是直接到HDFS上,而是先到Kafka,Kafka中的数据可以由多个消费者同时消费,其中一个消费者,就是将数据同步到HDFS。

如果你已然认真完整的学习了以上的内容,那么你应当早已具备以下技能和知识点:

为什么Spark比MapReduce快。

使用SparkSQL取代Hive,更快的运行SQL。

使用Kafka完成数据的一次搜集,多次消费构架。

自己可以写程序完成Kafka的生产者和消费者。

从后面的学习,你已然把握了大数据平台中的数据采集、数据储存和估算、数据交换等大部分技能,而这其中的每一步,都须要一个任务(程序)来完成,各个任务之间又存在一定的依赖性,比如,必须等数据采集任务成功完成后,数据估算任务能够开始运行。如果一个任务执行失败,需要给开发运维人员发送告警,同时须要提供完整的日志来便捷查错。

第七章:越来越多的剖析任务

不仅仅是剖析任务,数据采集、数据交换同样是一个个的任务。这些任务中,有的是定时触发,有点则须要依赖其他任务来触发。当平台中有几百上千个任务须要维护和运行时侯,仅仅靠crontab远远不够了,这时便须要一个调度监控系统来完成这件事。调度监控系统是整个数据平台的中枢系统,类似于AppMaster,负责分配和监控任务。

7.1 Apache Oozie

Oozie是哪些?有什么功能?

Oozie可以调度什么类型的任务(程序)?

Oozie可以支持什么任务触发形式?

安装配置Oozie。

7.2 其他开源的任务调度系统

Azkaban,light-task-scheduler,Zeus,等等。另外,我那边是之前单独开发的任务调度与监控系统,具体请参考《大数据平台任务调度与监控系统》。如果你认真完成了前面的学习和实践,此时,你的”大数据平台”应该是这样的:

第八章:我的数据要实时

在第六章介绍Kafka的时侯提及了一些须要实时指标的业务场景,实时基本可以分为绝对实时和准实时,绝对实时的延后要求通常在毫秒级,准实时的延后要求通常在秒、分钟级。对于须要绝对实时的业务场景,用的比较多的是Storm,对于其他准实时的业务场景,可以是Storm,也可以是Spark Streaming。当然,如果可以的话,也可以自己写程序来做。

8.1 Storm

什么是Storm?有什么可能的应用场景?

Storm由什么核心组件构成,各自兼任哪些角色?

Storm的简单安装和布署。

自己编撰Demo程序,使用Storm完成实时数据流估算。

8.2 Spark Streaming

什么是Spark Streaming,它和Spark是哪些关系?

Spark Streaming和Storm比较,各有哪些优缺点?

使用Kafka + Spark Streaming,完成实时估算的Demo程序。

至此,你的大数据平台底层构架早已成形了,其中包括了数据采集、数据储存与估算(离线和实时)、数据同步、任务调度与监控这几大模块。接下来是时侯考虑怎样更好的对外提供数据了。

第九章:数据要对外

通常对外(业务)提供数据访问,大体上收录以下方面。

离线:比如,每天将前一天的数据提供到指定的数据源(DB、FILE、FTP)等;离线数据的提供可以采用Sqoop、DataX等离线数据交换工具。

实时:比如,在线网站的推荐系统,需要实时从数据平台中获取给用户的推荐数据,这种要求延时特别低(50毫秒以内)。根据延时要求和实时数据的查询须要,可能的方案有:HBase、Redis、MongoDB、ElasticSearch等。

OLAP剖析:OLAP不仅要求底层的数据模型比较规范,另外,对查询的响应速率要求也越来越高,可能的方案有:Impala、Presto、SparkSQL、Kylin。如果你的数据模型比较规模,那么Kylin是最好的选择。

即席查询:即席查询的数据比较随便,一般很难构建通用的数据模型,因此可能的方案有:Impala、Presto、SparkSQL。

这么多比较成熟的框架和方案,需要结合自己的业务需求及数据平台技术构架,选择合适的。原则只有一个:越简单越稳定的,就是最好的。点击发放免费资料及课程

如果你已然把握了怎样挺好的对外(业务)提供数据,那么你的“大数据平台”应该是这样的:

第十章:牛逼高大上的机器学习

关于这块,也只能是简单介绍一下了,研究不深入。在业务中,遇到的能用机器学习解决的问题大约如此三类:

分类问题:包括二分类和多分类,二分类就是解决了预测的问题,就像预测一封电邮是否垃圾邮件;多分类解决的是文本的分类;

聚类问题:从用户搜索过的关键词,对用户进行大约的归类。 查看全部

不邀自答!

很多初学者在萌生向大数据方向发展的看法以后,不免形成一些疑惑,应该如何入门?应该学习什么技术?学习路线又是哪些?

所有萌生入行的看法与想要学习Java的朋友的本意是一样的。岗位十分火,就业起薪比较高,,前景十分可观。基本都是这个缘由而憧憬大数据,但是对大数据却不甚了解。

如果你想学习,那么首先你须要学会编程,其次你须要把握物理,统计学的知识,最后融合应用,就可以想在数据方向发展,笼统来说,就是这样的。但是仅仅这样并没有哪些帮助。

现在你须要问自己几个问题:

对于计算机/软件,你的兴趣是哪些?

是计算机专业,对操作系统、硬件、网络、服务器感兴趣?

是软件专业,对软件开发、编程、写代码感兴趣?

还是物理、统计学专业,对数据和数字非常感兴趣。

你自己的专业又是哪些?

如果你是金融专业,你可以学习,因为这结合上去你自己的专业,将使你在只有你专业知识的竞争者之中脱颖而出,毕竟现今AI+已经涉及到金融行业了。

说了这么多,无非就是想告诉你,大数据的三个大的发展方向:

平台搭建/优化/运维/监控;

大数据开发/ 设计/ 架构;

数据剖析/挖掘。

请不要问我那个容易,只能说能赚钱的都不简单。

说一下大数据的四个典型的特点:

数据量大;点击发放免费资料及课程

数据类型繁杂,(结构化、非结构化文本、日志、视频、图片、地理位置等);

商业价值高,但须要在海量数据之上,通过数据剖析与机器学习快速的挖掘下来;

处理时效性高,海量数据的处理需求不再局限在离线估算当中。

现如今,为了应对大数据的这几个特性,开源的大数据框架越来越多,越来越强,先列出一些常见的:

文件储存: N、Mesos

日志搜集:Flume、Scribe、Logstash、Kibana

消息系统:Kafka、StormMQ、ZeroMQ、RabbitMQ

查询剖析:Hive、Impala、Pig、Presto、Phoenix、SparkSQL、Drill、Flink、Kylin、Druid

分布式协调服务:Zookeeper

集群管理与监控:Ambari、Ganglia、Nagios、Cloudera Manager

数据挖掘、机器学习:Mahout、Spark MLLib

数据同步:Sqoop

任务调度:Oozie

是不是眼花缭乱了,上面的那些内容,别谈精通了,就算全部就会使用的,应该也没几个。咱们接下来就大数据开发/ 设计/ 架构方向来了解一下学习路线。

在接下的学习中,不论遇见哪些问题,先试试搜索并自己解决。Google首选,其次百度。

于入门者而言,官方文档永远是首选文档。

第一章:Hadoop

在大数据储存和估算中Hadoop可以算是开山鼻祖,现在大多开源的大数据框架都依赖Hadoop或则与它能挺好的兼容。

关于Hadoop,你起码须要搞清楚那些是哪些:

Hadoop 1.0、Hadoop 2.0

MapReduce、HDFS

NameNode、DataNode

JobTracker、TaskTracker

Yarn、ResourceManager、NodeManager

自己学会怎样搭建Hadoop,先使它跑起来。建议先使用安装包命令行安装,不要使用管理工具安装。现在都用Hadoop 2.0。

HDFS目录操作命令;上传、下载文件命令;提交运行MapReduce示例程序;打开Hadoop WEB界面,查看Job运行状态,查看Job运行日志。知道Hadoop的系统日志在那里。

以上完成以后,就应当去了解她们的原理了:

MapReduce:如何分而治之;HDFS:数据究竟在那里,究竟哪些才是副本;

Yarn究竟是什么,它能干哪些;NameNode究竟在干些哪些;Resource Manager究竟在干些哪些;

如果有合适的学习网站,视频就去听课,如果没有或则比较喜欢书籍,也可以啃书。当然最好的方式是先去搜索下来那些是干哪些的,大概有了概念以后,然后再去听视频。

之后便是自己找寻一个事例:

自己写一个(照抄也行)WordCount程序,

打包并递交到Hadoop运行。你不会Java?Shell、Python都可以,有个东西叫Hadoop Streaming。如果你认真完成了以上几步,恭喜你,你的一只脚早已进来了。

第二章:更高效的WordCount

在这里,一定要学习SQL,它会对你的工作有很大的帮助。

就像是你写(或者抄)的WordCount一共有几行代码?但是你用SQL就十分简单了,例如:

SELECT word,COUNT(1) FROM wordcount GROUP BY word;

这便是SQL的魅力,编程须要几十行,甚至上百行代码,而SQL一行搞定;使用SQL处理剖析Hadoop上的数据,方便、高效、易上手、更是趋势。不论是离线估算还是实时估算,越来越多的大数据处理框架都在积极提供SQL插口。

另外就是SQL On Hadoop之Hive于大数据而言一定要学习的。

什么是Hive?

官方解释如下:The Apache Hive data warehouse software facilitates reading, writing, and managing large datasets residing in distributed storage and queried using SQL syntax。

为什么说Hive是数据库房工具,而不是数据库工具呢?

有的同学可能不知道数据库房,数据库房是逻辑上的概念,底层使用的是数据库,数据库房中的数据有这两个特征:最全的历史数据(海量)、相对稳定的;所谓相对稳定,指的是数据库房不同于业务系统数据库,数据常常会被更新,数据一旦步入数据库房,很少会被更新和删掉,只会被大量查询。而Hive,也是具备这两个特性,因此,Hive适宜做海量数据的数据库房工具,而不是数据库工具。

了解了它的作用以后,就是安装配置Hive的环节,当可以正常步入Hive命令行是,就是安装配置成功了。

了解Hive是如何工作的

学会Hive的基本命令:

创建、删除表;加载数据到表;下载Hive表的数据;

MapReduce的原理(还是那种精典的题目,一个10G大小的文件,给定1G大小的显存,如何使用Java程序统计出现次数最多的10个词组及次数);

HDFS读写数据的流程;向HDFS中PUT数据;从HDFS中下载数据;

自己会写简单的MapReduce程序,运行出现问题,知道在那儿查看日志;

会写简单的Select、Where、group by等SQL句子;

Hive SQL转换成MapReduce的大致流程;

Hive中常见的句子:创建表、删除表、往表中加载数据、分区、将表中数据下载到本地;

从前面的学习,你已然了解到,HDFS是Hadoop提供的分布式储存框架,它可以拿来储存海量数据,MapReduce是Hadoop提供的分布式估算框架,它可以拿来统计和剖析HDFS上的海量数据,而Hive则是SQL On Hadoop,Hive提供了SQL插口,开发人员只须要编撰简单易上手的SQL句子,Hive负责把SQL翻译成MapReduce,提交运行。

此时,你的”大数据平台”是这样的:那么问题来了,海量数据怎么到HDFS上呢?

第三章:数据采集

把各个数据源的数据采集到Hadoop上。

3.1 HDFS PUT命令

这个在上面你应当早已使用过了。put命令在实际环境中也比较常用,通常配合shell、python等脚本语言来使用。建议熟练把握。

3.2 HDFS API

HDFS提供了写数据的API,自己用编程语言将数据写入HDFS,put命令本身也是使用API。

实际环境中通常自己较少编撰程序使用API来写数据到HDFS,通常都是使用其他框架封装好的技巧。比如:Hive中的INSERT句子,Spark中的saveAsTextfile等。建议了解原理,会写Demo。

3.3 Sqoop

Sqoop是一个主要用于Hadoop/Hive与传统关系型数据库,Oracle、MySQL、SQLServer等之间进行数据交换的开源框架。就像Hive把SQL翻译成MapReduce一样,Sqoop把你指定的参数翻译成MapReduce,提交到Hadoop运行,完成Hadoop与其他数据库之间的数据交换。

自己下载和配置Sqoop(建议先使用Sqoop1,Sqoop2比较复杂)。了解Sqoop常用的配置参数和技巧。

使用Sqoop完成从MySQL同步数据到HDFS;使用Sqoop完成从MySQL同步数据到Hive表;如果后续选型确定使用Sqoop作为数据交换工具,那么建议熟练把握,否则,了解和会用Demo即可。

3.4 Flume

Flume是一个分布式的海量日志采集和传输框架,因为“采集和传输框架”,所以它并不适宜关系型数据库的数据采集和传输。Flume可以实时的从网路合同、消息系统、文件系统采集日志,并传输到HDFS上。

因此,如果你的业务有这种数据源的数据,并且须要实时的采集,那么就应当考虑使用Flume。

下载和配置Flume。使用Flume监控一个不断追加数据的文件,并将数据传输到HDFS;Flume的配置和使用较为复杂,如果你没有足够的兴趣和耐心,可以先跳过Flume。

3.5 阿里开源的DataX

之所以介绍这个,是因为我们公司目前使用的Hadoop与关系型数据库数据交换的工具,就是之前基于DataX开发的,非常好用。

可以参考我的博文《异构数据源海量数据交换工具-Taobao DataX 下载和使用》。现在DataX早已是3.0版本,支持好多数据源。你也可以在其之上做二次开发。有兴趣的可以研究和使用一下,对比一下它与Sqoop。

第四章:把Hadoop上的数据搞到别处去

Hive和MapReduce进行剖析了。那么接下来的问题是,分析完的结果怎样从Hadoop上同步到其他系统和应用中去呢?其实,此处的方式和第三章基本一致的。

HDFS GET命令:把HDFS上的文件GET到本地。需要熟练把握。

HDFS API:同3.2.

Sqoop:同3.3.使用Sqoop完成将HDFS上的文件同步到MySQL;使用Sqoop完成将Hive表中的数据同步到MySQL。

如果你早已根据流程认真完整的走了一遍,那么你应当早已具备以下技能和知识点:

知道怎样把已有的数据采集到HDFS上,包括离线采集和实时采集;

知道sqoop是HDFS和其他数据源之间的数据交换工具;

知道flume可以用作实时的日志采集。

从后面的学习,对于大数据平台,你已然把握的不少的知识和技能,搭建Hadoop集群,把数据采集到Hadoop上,使用Hive和MapReduce来剖析数据,把剖析结果同步到其他数据源。

接下来的问题来了,Hive使用的越来越多,你会发觉好多不爽的地方,特别是速率慢,大多情况下,明明我的数据量太小,它都要申请资源,启动MapReduce来执行。

第五章:SQL

其实你们都早已发觉Hive后台使用MapReduce作为执行引擎,实在是有点慢。因此SQL On Hadoop的框架越来越多,点击发放免费资料及课程按我的了解,最常用的根据流行度依次为SparkSQL、Impala和Presto.这三种框架基于半显存或则全显存,提供了SQL插口来快速查询剖析Hadoop上的数据。

我们目前使用的是SparkSQL,至于为何用SparkSQL,原因大约有以下吧:使用Spark还做了其他事情,不想引入过多的框架;Impala对显存的需求很大,没有过多资源布署。

5.1 关于Spark和SparkSQL

什么是Spark,什么是SparkSQL。

Spark有的核心概念及名词解释。

SparkSQL和Spark是哪些关系,SparkSQL和Hive是哪些关系。

SparkSQL为何比Hive跑的快。

5.2 如何布署和运行SparkSQL

Spark有什么布署模式?

如何在Yarn上运行SparkSQL?

使用SparkSQL查询Hive中的表。Spark不是一门短时间内能够把握的技术,因此建议在了解了Spark以后,可以先从SparkSQL入手,循序渐进。

关于Spark和SparkSQL,如果你认真完成了里面的学习和实践,此时,你的”大数据平台”应该是这样的。

第六章:数据多次借助

请不要被这个名子所诱惑。其实我想说的是数据的一次采集、多次消费。

在实际业务场景下,特别是对于一些监控日志,想即时的从日志中了解一些指标(关于实时估算,后面章节会有介绍),这时候,从HDFS上剖析就很慢了,尽管是通过Flume采集的,但Flume也不能间隔太短就往HDFS上滚动文件,这样会导致小文件非常多。

为了满足数据的一次采集、多次消费的需求,这里要说的便是Kafka。

关于Kafka:什么是Kafka?Kafka的核心概念及名词解释。

如何布署和使用Kafka:使用单机布署Kafka,并成功运行自带的生产者和消费者事例。使用Java程序自己编撰并运行生产者和消费者程序。Flume和Kafka的集成,使用Flume监控日志,并将日志数据实时发送至Kafka。

如果你认真完成了前面的学习和实践,此时,你的”大数据平台”应该是这样的。

这时,使用Flume采集的数据,不是直接到HDFS上,而是先到Kafka,Kafka中的数据可以由多个消费者同时消费,其中一个消费者,就是将数据同步到HDFS。

如果你已然认真完整的学习了以上的内容,那么你应当早已具备以下技能和知识点:

为什么Spark比MapReduce快。

使用SparkSQL取代Hive,更快的运行SQL。

使用Kafka完成数据的一次搜集,多次消费构架。

自己可以写程序完成Kafka的生产者和消费者。

从后面的学习,你已然把握了大数据平台中的数据采集、数据储存和估算、数据交换等大部分技能,而这其中的每一步,都须要一个任务(程序)来完成,各个任务之间又存在一定的依赖性,比如,必须等数据采集任务成功完成后,数据估算任务能够开始运行。如果一个任务执行失败,需要给开发运维人员发送告警,同时须要提供完整的日志来便捷查错。

第七章:越来越多的剖析任务

不仅仅是剖析任务,数据采集、数据交换同样是一个个的任务。这些任务中,有的是定时触发,有点则须要依赖其他任务来触发。当平台中有几百上千个任务须要维护和运行时侯,仅仅靠crontab远远不够了,这时便须要一个调度监控系统来完成这件事。调度监控系统是整个数据平台的中枢系统,类似于AppMaster,负责分配和监控任务。

7.1 Apache Oozie

Oozie是哪些?有什么功能?

Oozie可以调度什么类型的任务(程序)?

Oozie可以支持什么任务触发形式?

安装配置Oozie。

7.2 其他开源的任务调度系统

Azkaban,light-task-scheduler,Zeus,等等。另外,我那边是之前单独开发的任务调度与监控系统,具体请参考《大数据平台任务调度与监控系统》。如果你认真完成了前面的学习和实践,此时,你的”大数据平台”应该是这样的:

第八章:我的数据要实时

在第六章介绍Kafka的时侯提及了一些须要实时指标的业务场景,实时基本可以分为绝对实时和准实时,绝对实时的延后要求通常在毫秒级,准实时的延后要求通常在秒、分钟级。对于须要绝对实时的业务场景,用的比较多的是Storm,对于其他准实时的业务场景,可以是Storm,也可以是Spark Streaming。当然,如果可以的话,也可以自己写程序来做。

8.1 Storm

什么是Storm?有什么可能的应用场景?

Storm由什么核心组件构成,各自兼任哪些角色?

Storm的简单安装和布署。

自己编撰Demo程序,使用Storm完成实时数据流估算。

8.2 Spark Streaming

什么是Spark Streaming,它和Spark是哪些关系?

Spark Streaming和Storm比较,各有哪些优缺点?

使用Kafka + Spark Streaming,完成实时估算的Demo程序。

至此,你的大数据平台底层构架早已成形了,其中包括了数据采集、数据储存与估算(离线和实时)、数据同步、任务调度与监控这几大模块。接下来是时侯考虑怎样更好的对外提供数据了。

第九章:数据要对外

通常对外(业务)提供数据访问,大体上收录以下方面。

离线:比如,每天将前一天的数据提供到指定的数据源(DB、FILE、FTP)等;离线数据的提供可以采用Sqoop、DataX等离线数据交换工具。

实时:比如,在线网站的推荐系统,需要实时从数据平台中获取给用户的推荐数据,这种要求延时特别低(50毫秒以内)。根据延时要求和实时数据的查询须要,可能的方案有:HBase、Redis、MongoDB、ElasticSearch等。

OLAP剖析:OLAP不仅要求底层的数据模型比较规范,另外,对查询的响应速率要求也越来越高,可能的方案有:Impala、Presto、SparkSQL、Kylin。如果你的数据模型比较规模,那么Kylin是最好的选择。

即席查询:即席查询的数据比较随便,一般很难构建通用的数据模型,因此可能的方案有:Impala、Presto、SparkSQL。

这么多比较成熟的框架和方案,需要结合自己的业务需求及数据平台技术构架,选择合适的。原则只有一个:越简单越稳定的,就是最好的。点击发放免费资料及课程

如果你已然把握了怎样挺好的对外(业务)提供数据,那么你的“大数据平台”应该是这样的:

第十章:牛逼高大上的机器学习

关于这块,也只能是简单介绍一下了,研究不深入。在业务中,遇到的能用机器学习解决的问题大约如此三类:

分类问题:包括二分类和多分类,二分类就是解决了预测的问题,就像预测一封电邮是否垃圾邮件;多分类解决的是文本的分类;

聚类问题:从用户搜索过的关键词,对用户进行大约的归类。

SpringMVC开发了Restful API参数采集方法

采集交流 • 优采云 发表了文章 • 0 个评论 • 317 次浏览 • 2020-08-08 21:41

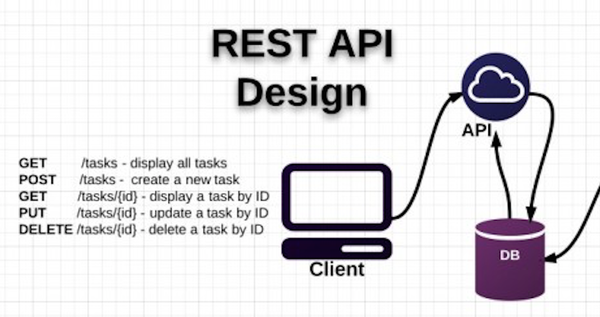

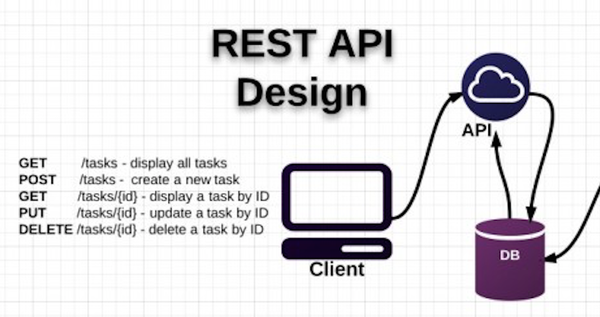

1. Restful API的简单描述

一种软件架构风格,设计风格而不是标准,只是提供了一组设计原则和约束条件。Web 应用程序最重要的 REST 原则是,客户端和服务器之间的交互在请求之间是无状态的。从客户端到服务器的每个请求都必须包含理解请求所必需的信息。如果服务器在请求之间的任何时间点重启,客户端不会得到通知。此外,无状态请求可以由任何可用服务器回答。

Rest:表述性状态转移

在Server提供的RESTful API中,URL中仅使用名词来指定资源. 原则上,不使用动词. HTTP协议中的动词用于添加,修改和删除资源. 也就是说,资源状态通过HTTP动词反转:

GET用于获取资源,

POST用于创建新资源(也可以用于更新资源)

PUT用于更新资源,

DELETE用于删除资源.

2. 采集参数问题

在设计Restful API时,很多时候需要以不同的方式采集参数,例如登录,更新帐户等. 下面着重介绍不同请求方法下的参数采集问题. 原则上,前端和后端使用json作为数据交换格式. (用于: SpringMVC,JQuery,AJAX,JSP)

测试按钮编写表格:

2.1RequestMethod.GET

在get请求中,默认参数提交方法反映在url中. get请求是获取服务器端数据. 不建议提交复杂的数据类型. 如果涉及多种数据或复杂数据类型,则需要更改为过帐. ,以下是获取请求的示例:

: 8080 / api / user?userName = kent&userId = 1

背景写法:

@RequestMapping(value = "/login",method = RequestMethod.GET)

public JsonResult login(@RequestParam("mydata") String data){

System.out.println(data);

return new SuccessResult().setData(data);

}

JsonResult和SuccessResult是自定义数据结构,以促进与Json的前端和后端交互. @RequestParam是用于接收请求参数的标签,当变量名称与请求参数名称名称不一致时,使用value来指定请求参数.

示例请求网址: 9999 / login?mydata = hello

前景符号:

$("#button3").click(function () {

var mydata = "mydata=hello";

var url = "/login";

$.ajax({

url : url,

type : 'GET',

data : mydata

});

});

请求数据以字符串形式进行拼接,后台采集的参数是你好

2.2RequestMethod.POST

在这种类型的请求中,参数可以封装在实体类中. 当后台接收到数据时,框架将自动解析并将数据映射到JavaBean. 邮政请求方法是将前端客户输入的数据提交到后台进行处理. 数据安全性.

背景写作方法

@RequestMapping(value = "/login",method = RequestMethod.POST)

public JsonResult login(@RequestBody Address address){

System.out.println(address);

return new SuccessResult();

}

前景符号:

$("#button3").click(function () {

var url = "/login";

var address = {};

address['id'] = 1;

address['province'] = "maopp";

address['city'] = "hihihi";

$.ajax({

url : url,

type : 'POST',

contentType: "application/json;charset=utf-8",

data : JSON.stringify(address)

});

});

规范前台参数时要注意两点. 一种是内容类型,默认的内容类型是application / x-www-form-urlencoded. 如果要向服务器提交数据,则需要将内容类型指定为application / json. 否则,服务器接收到的为空;第二点是使用JSON.strinify()函数将数据格式化为Json格式.

2.3RequestMethod.PUT

用于更新资源的参数提交方法类似于post

背景写法:

@RequestMapping(value = "/login",method = RequestMethod.PUT)

public JsonResult login(@RequestBody Address address){

System.out.println(address);

return new SuccessResult();

}

前端写入方法:

$("#button3").click(function () {

var url = "/login";

var address = {};

address['id'] = 1;

address['province'] = "maopp";

address['city'] = "hihihi";

$.ajax({

url : url,

type : 'PUT',

contentType: "application/json;charset=utf-8",

data : JSON.stringify(address)

});

});

2.4RequestMethod.DELETE

它用于删除资源或注销帐户. 您可以在url或Json表单中提交参数. 在大多数情况下,您只需要传递整数类型的数据(例如,要删除用户,只需提交用户ID)

背景写作形式:

@RequestMapping(value = "/deleteUser/{id}",method = RequestMethod.DELETE

)

public JsonResult logout(@PathVariable Integer id){

//注销session

userService.deleteById(id);

}

使用@PathVariable批注支持从请求的URL中获取数据. 应该注意的是,URL上的参数名称必须与方法中的变量名称一致. 查看全部

内容

1. Restful API的简单描述

一种软件架构风格,设计风格而不是标准,只是提供了一组设计原则和约束条件。Web 应用程序最重要的 REST 原则是,客户端和服务器之间的交互在请求之间是无状态的。从客户端到服务器的每个请求都必须包含理解请求所必需的信息。如果服务器在请求之间的任何时间点重启,客户端不会得到通知。此外,无状态请求可以由任何可用服务器回答。

Rest:表述性状态转移

在Server提供的RESTful API中,URL中仅使用名词来指定资源. 原则上,不使用动词. HTTP协议中的动词用于添加,修改和删除资源. 也就是说,资源状态通过HTTP动词反转:

GET用于获取资源,

POST用于创建新资源(也可以用于更新资源)

PUT用于更新资源,

DELETE用于删除资源.

2. 采集参数问题

在设计Restful API时,很多时候需要以不同的方式采集参数,例如登录,更新帐户等. 下面着重介绍不同请求方法下的参数采集问题. 原则上,前端和后端使用json作为数据交换格式. (用于: SpringMVC,JQuery,AJAX,JSP)

测试按钮编写表格:

2.1RequestMethod.GET

在get请求中,默认参数提交方法反映在url中. get请求是获取服务器端数据. 不建议提交复杂的数据类型. 如果涉及多种数据或复杂数据类型,则需要更改为过帐. ,以下是获取请求的示例:

: 8080 / api / user?userName = kent&userId = 1

背景写法:

@RequestMapping(value = "/login",method = RequestMethod.GET)

public JsonResult login(@RequestParam("mydata") String data){

System.out.println(data);

return new SuccessResult().setData(data);

}

JsonResult和SuccessResult是自定义数据结构,以促进与Json的前端和后端交互. @RequestParam是用于接收请求参数的标签,当变量名称与请求参数名称名称不一致时,使用value来指定请求参数.

示例请求网址: 9999 / login?mydata = hello

前景符号:

$("#button3").click(function () {

var mydata = "mydata=hello";

var url = "/login";

$.ajax({

url : url,

type : 'GET',

data : mydata

});

});

请求数据以字符串形式进行拼接,后台采集的参数是你好

2.2RequestMethod.POST

在这种类型的请求中,参数可以封装在实体类中. 当后台接收到数据时,框架将自动解析并将数据映射到JavaBean. 邮政请求方法是将前端客户输入的数据提交到后台进行处理. 数据安全性.

背景写作方法

@RequestMapping(value = "/login",method = RequestMethod.POST)

public JsonResult login(@RequestBody Address address){

System.out.println(address);

return new SuccessResult();

}

前景符号:

$("#button3").click(function () {

var url = "/login";

var address = {};

address['id'] = 1;

address['province'] = "maopp";

address['city'] = "hihihi";

$.ajax({

url : url,

type : 'POST',

contentType: "application/json;charset=utf-8",

data : JSON.stringify(address)

});

});

规范前台参数时要注意两点. 一种是内容类型,默认的内容类型是application / x-www-form-urlencoded. 如果要向服务器提交数据,则需要将内容类型指定为application / json. 否则,服务器接收到的为空;第二点是使用JSON.strinify()函数将数据格式化为Json格式.

2.3RequestMethod.PUT

用于更新资源的参数提交方法类似于post

背景写法:

@RequestMapping(value = "/login",method = RequestMethod.PUT)

public JsonResult login(@RequestBody Address address){

System.out.println(address);

return new SuccessResult();

}

前端写入方法:

$("#button3").click(function () {

var url = "/login";

var address = {};

address['id'] = 1;

address['province'] = "maopp";

address['city'] = "hihihi";

$.ajax({

url : url,

type : 'PUT',

contentType: "application/json;charset=utf-8",

data : JSON.stringify(address)

});

});

2.4RequestMethod.DELETE

它用于删除资源或注销帐户. 您可以在url或Json表单中提交参数. 在大多数情况下,您只需要传递整数类型的数据(例如,要删除用户,只需提交用户ID)

背景写作形式:

@RequestMapping(value = "/deleteUser/{id}",method = RequestMethod.DELETE

)

public JsonResult logout(@PathVariable Integer id){

//注销session

userService.deleteById(id);

}

使用@PathVariable批注支持从请求的URL中获取数据. 应该注意的是,URL上的参数名称必须与方法中的变量名称一致.

CMDB项目获取今天的未收资产清单和API验证

采集交流 • 优采云 发表了文章 • 0 个评论 • 164 次浏览 • 2020-08-08 20:53

要点:

1. 在服务器表中添加两个字段: latest_date(可以为空);服务器状态信息;

2. 在什么情况下会获得未采集的服务器信息?

①当last_date为空时,例如尚未报告的资产的初始创建;

②今天尚未采集,请注意latest_date__date__lt

③服务器状态为在线

3. 设置current_date = datetime.datetime.now();服务器更新资产时.

4,get_host_list函数:

注意: 内容放置在response.text部分(response = request.get(url))

代码区:

###############服务端###############

@csrf_exempt

def server(request):

'''

requests不能发送字典类型数据,纵观我们学的form表单提交数据,

ajax发送数据,均是不支持字典类型数据的发送的。

具体原因百度知晓。

:param request:

:return:

'''

if request.method == 'GET':

# 获取今日未采集主机列表[latest_date为None或者latest_date不为今日且服务器状态为在线]

current_date = date.today()

host_list = models.Server.objects.filter(

Q(Q(latest_date=None) | Q(latest_date__date__lt=current_date)) & Q(server_status_id=2)).values('hostname')

'''

['hostname':'c1.com']

'''

host_list = list(host_list)

print(host_list)

return HttpResponse(json.dumps(host_list))

#############客户端#############

class SshSaltClient(BaseClient):

def get_host_list(self):

response=requests.get(self.api) #

# print(response.text) # [{"hostname": "c1.com"}]注意这种用法

return json.loads(response.text)

API验证

要点: 通过三个级别

第一级: 时间限制(超出客户时间和服务器之间的时间,我们的团队要求限制)

第二遍: 加密规则限制(主要使用MD5加密)

第三遍: 对于已访问的加密str,我们设置访问列表. 普通用户不可能再次向服务器请求此访问数据. 如果列表中没有str,则表明这是正常的用户访问. 请记住,数据已添加到访问列表.

此内容将越来越大,并且实际上将应用于memcache和redis.

最后三个级别基本上可以达到防止黑客攻击的效果,但是并不排除黑客的网络速度比我们的速度快. 我们最好对要发送的数据进行加密,然后更早地提交黑客的网络速度. 是否可以去服务器?

代码区:

##############客户端##############

import requests

import time

import hashlib

def md5(arg):

md5 = hashlib.md5()

md5.update(arg.encode('utf-8'))

return md5.hexdigest()

key = 'asdfghjklmnbvcxz'

ctime = str(time.time())

client_str = '%s|%s' % (key, ctime)

client_md5_str = md5(client_str)

client_header_str = '%s|%s' % (client_md5_str, ctime)

print(client_header_str)

response = requests.get(url='http://127.0.0.1:8000/api/tests.html', headers={'auth-api': 'cae76146bfa06482cfee7e4f899cc414|1506956350.973326'})

print(response.text)

##############服务端##############

def md5(arg):

md5 = hashlib.md5()

md5.update(arg.encode('utf-8'))

return md5.hexdigest()

key = 'asdfghjklmnbvcxz'

vistied_str_dict={}

def tests(request):

client_header_str = request.META.get('HTTP_AUTH_API')

print(client_header_str)

client_md5_str, client_ctime = client_header_str.split('|', maxsplit=1)

client_float_ctime = float(client_ctime)

server_float_ctime = float(time.time())

# 第一关

if (client_float_ctime + 20) < server_float_ctime:

return HttpResponse("太慢了")

# 第二关

server_str = '%s|%s' % (key, client_ctime)

server_md5_str = md5(server_str)

if client_md5_str != server_md5_str:

return HttpResponse('休想')

# 第三关

if vistied_str_dict.get(client_md5_str):

return HttpResponse('放弃吧')

else:

vistied_str_dict[client_md5_str] = client_ctime

return HttpResponse('你得到我了')

最后,装饰器未使用,明天将添加. 查看全部

获取今天未收资产的列表:

要点:

1. 在服务器表中添加两个字段: latest_date(可以为空);服务器状态信息;

2. 在什么情况下会获得未采集的服务器信息?

①当last_date为空时,例如尚未报告的资产的初始创建;

②今天尚未采集,请注意latest_date__date__lt

③服务器状态为在线

3. 设置current_date = datetime.datetime.now();服务器更新资产时.

4,get_host_list函数:

注意: 内容放置在response.text部分(response = request.get(url))

代码区:

###############服务端###############

@csrf_exempt

def server(request):

'''

requests不能发送字典类型数据,纵观我们学的form表单提交数据,

ajax发送数据,均是不支持字典类型数据的发送的。

具体原因百度知晓。

:param request:

:return:

'''

if request.method == 'GET':

# 获取今日未采集主机列表[latest_date为None或者latest_date不为今日且服务器状态为在线]

current_date = date.today()

host_list = models.Server.objects.filter(

Q(Q(latest_date=None) | Q(latest_date__date__lt=current_date)) & Q(server_status_id=2)).values('hostname')

'''

['hostname':'c1.com']

'''

host_list = list(host_list)

print(host_list)

return HttpResponse(json.dumps(host_list))

#############客户端#############

class SshSaltClient(BaseClient):

def get_host_list(self):

response=requests.get(self.api) #

# print(response.text) # [{"hostname": "c1.com"}]注意这种用法

return json.loads(response.text)

API验证

要点: 通过三个级别

第一级: 时间限制(超出客户时间和服务器之间的时间,我们的团队要求限制)

第二遍: 加密规则限制(主要使用MD5加密)

第三遍: 对于已访问的加密str,我们设置访问列表. 普通用户不可能再次向服务器请求此访问数据. 如果列表中没有str,则表明这是正常的用户访问. 请记住,数据已添加到访问列表.

此内容将越来越大,并且实际上将应用于memcache和redis.

最后三个级别基本上可以达到防止黑客攻击的效果,但是并不排除黑客的网络速度比我们的速度快. 我们最好对要发送的数据进行加密,然后更早地提交黑客的网络速度. 是否可以去服务器?

代码区:

##############客户端##############

import requests

import time

import hashlib

def md5(arg):

md5 = hashlib.md5()

md5.update(arg.encode('utf-8'))

return md5.hexdigest()

key = 'asdfghjklmnbvcxz'

ctime = str(time.time())

client_str = '%s|%s' % (key, ctime)

client_md5_str = md5(client_str)

client_header_str = '%s|%s' % (client_md5_str, ctime)

print(client_header_str)

response = requests.get(url='http://127.0.0.1:8000/api/tests.html', headers={'auth-api': 'cae76146bfa06482cfee7e4f899cc414|1506956350.973326'})

print(response.text)

##############服务端##############

def md5(arg):

md5 = hashlib.md5()

md5.update(arg.encode('utf-8'))

return md5.hexdigest()

key = 'asdfghjklmnbvcxz'

vistied_str_dict={}

def tests(request):

client_header_str = request.META.get('HTTP_AUTH_API')

print(client_header_str)

client_md5_str, client_ctime = client_header_str.split('|', maxsplit=1)

client_float_ctime = float(client_ctime)

server_float_ctime = float(time.time())

# 第一关

if (client_float_ctime + 20) < server_float_ctime:

return HttpResponse("太慢了")

# 第二关

server_str = '%s|%s' % (key, client_ctime)

server_md5_str = md5(server_str)

if client_md5_str != server_md5_str:

return HttpResponse('休想')

# 第三关

if vistied_str_dict.get(client_md5_str):

return HttpResponse('放弃吧')

else:

vistied_str_dict[client_md5_str] = client_ctime

return HttpResponse('你得到我了')

最后,装饰器未使用,明天将添加.

[Transfer] Dynamics CRM 365的从零开始的入门学习(3)通过Dynamics

采集交流 • 优采云 发表了文章 • 0 个评论 • 266 次浏览 • 2020-08-08 14:00

实现效果

(1)实现html页面并将其导入系统

在设置中找到自定义项,然后转到自定义系统,选择Web资源,然后将先前准备的页面上传到系统.

(2)自定义操作

首先创建一个新动作,可以将实体设置设置为全局,也可以单独设置一个实体.

注意:

注册动作,方法与插件注册相同. 在注册步骤时,消息将选择我们操作的唯一名称. 许多人没有在此步骤的消息中显示操作的名称. 请确保两点: 首先,您的操作已激活;其次,在您激活操作后打开了插件注册器.

设置动作后,在此设置两个输入参数和一个输出参数. 设置后,保存并激活.

(3)开发插件项目

在此我们简要介绍该插件的基本用法

1. 要继承IPlugin,并实现Executive方法.

2. 从服务提供商那里获取执行上下文

3. 我们可以检查启动插件的实体名称

4. 您还可以检查触发的事件,无论是创建,更新还是删除

5. 在输入参数中获取触发的实体

6. 通过服务工厂获取IOrganizationService. 如果CreateOrganizationService方法的参数为null,则表示系统用户;如果参数为context.UserId或Guid.Empty,则表示当前用户.

7. 最后,DoAction方法,即插件的逻辑可以在这里实现.

以下是实现该插件的代码:

public void Execute(IServiceProvider serviceProvider)

{

IPluginExecutionContext context = (IPluginExecutionContext)serviceProvider.GetService

(typeof(IPluginExecutionContext));

IOrganizationServiceFactory serviceFactory = (IOrganizationServiceFactory)serviceProvider

.GetService(typeof(IOrganizationServiceFactory));

IOrganizationService service = serviceFactory.CreateOrganizationService(context.UserId);

//传入两个参数

String InParameters1 = context.InputParameters["InParameters1"] as String;

String InParameters2 = context.InputParameters["InParameters2"] as String;

//查询

//EntityReference entityRef = context.InputParameters["Target"] as EntityReference;

string fetchProductXml = @"

";

EntityCollection products = service.RetrieveMultiple(new FetchExpression(fetchProductXml));

//传出参数

context.OutputParameters["OutParameters"] = products;

//遍历products

foreach (var pair in products.Entities)

{

foreach (var pa in pair.Attributes)

{

Console.WriteLine(pa.Key + ": " + pa.Value);

}

}

Console.WriteLine(products);

}

(4)数据查询方法,本文使用FetchXML

在上面的代码实现中,我使用FetchXML来实现它. 对于多条件跨表查询,返回多个记录非常方便. 常用的结构如下,

SDK中有很多类似的情况.

我们可以使用高级查询来自动生成XML

最后我们可以导出XML文件

(5)Js调用自定义操作

最后,您可以看到输出结果:

摘要:

在内部部署的开发中,我们通常将复杂的业务处理逻辑封装到用于前端js调用的接口中,但是在在线开发中,这种开发方法无疑会增加成本(必须设置设置另一台服务器,添加域名并配置https协议证书等),通过网络api调用动作为我们提供了一种新的可行方式. 需求得到满足. 在下一章中,我们将分享调试插件的方法. 查看全部

要立即实现搜索产品功能,必须首先在页面上显示数据,然后前端将根据查询要求对其进行处理. 它以前是在salesforce中实现的. 您可以定义“搜索产品”页面,然后访问查询该页面上数据的Web服务. 但是在Dynamic 365中,没有这种直接调用方法. 最后,找到一种方法,使前端页面通过Js在工作流中调用Action,并将插件绑定到Action.

实现效果

(1)实现html页面并将其导入系统

在设置中找到自定义项,然后转到自定义系统,选择Web资源,然后将先前准备的页面上传到系统.

(2)自定义操作

首先创建一个新动作,可以将实体设置设置为全局,也可以单独设置一个实体.

注意:

注册动作,方法与插件注册相同. 在注册步骤时,消息将选择我们操作的唯一名称. 许多人没有在此步骤的消息中显示操作的名称. 请确保两点: 首先,您的操作已激活;其次,在您激活操作后打开了插件注册器.

设置动作后,在此设置两个输入参数和一个输出参数. 设置后,保存并激活.

(3)开发插件项目

在此我们简要介绍该插件的基本用法

1. 要继承IPlugin,并实现Executive方法.

2. 从服务提供商那里获取执行上下文

3. 我们可以检查启动插件的实体名称

4. 您还可以检查触发的事件,无论是创建,更新还是删除

5. 在输入参数中获取触发的实体

6. 通过服务工厂获取IOrganizationService. 如果CreateOrganizationService方法的参数为null,则表示系统用户;如果参数为context.UserId或Guid.Empty,则表示当前用户.

7. 最后,DoAction方法,即插件的逻辑可以在这里实现.

以下是实现该插件的代码:

public void Execute(IServiceProvider serviceProvider)

{

IPluginExecutionContext context = (IPluginExecutionContext)serviceProvider.GetService

(typeof(IPluginExecutionContext));

IOrganizationServiceFactory serviceFactory = (IOrganizationServiceFactory)serviceProvider

.GetService(typeof(IOrganizationServiceFactory));

IOrganizationService service = serviceFactory.CreateOrganizationService(context.UserId);

//传入两个参数

String InParameters1 = context.InputParameters["InParameters1"] as String;

String InParameters2 = context.InputParameters["InParameters2"] as String;

//查询

//EntityReference entityRef = context.InputParameters["Target"] as EntityReference;

string fetchProductXml = @"

";

EntityCollection products = service.RetrieveMultiple(new FetchExpression(fetchProductXml));

//传出参数

context.OutputParameters["OutParameters"] = products;

//遍历products

foreach (var pair in products.Entities)

{

foreach (var pa in pair.Attributes)

{

Console.WriteLine(pa.Key + ": " + pa.Value);

}

}

Console.WriteLine(products);

}

(4)数据查询方法,本文使用FetchXML

在上面的代码实现中,我使用FetchXML来实现它. 对于多条件跨表查询,返回多个记录非常方便. 常用的结构如下,

SDK中有很多类似的情况.

我们可以使用高级查询来自动生成XML

最后我们可以导出XML文件

(5)Js调用自定义操作

最后,您可以看到输出结果:

摘要:

在内部部署的开发中,我们通常将复杂的业务处理逻辑封装到用于前端js调用的接口中,但是在在线开发中,这种开发方法无疑会增加成本(必须设置设置另一台服务器,添加域名并配置https协议证书等),通过网络api调用动作为我们提供了一种新的可行方式. 需求得到满足. 在下一章中,我们将分享调试插件的方法.

微信公众号文章采集并发布到WordPress

采集交流 • 优采云 发表了文章 • 0 个评论 • 588 次浏览 • 2020-08-08 01:05

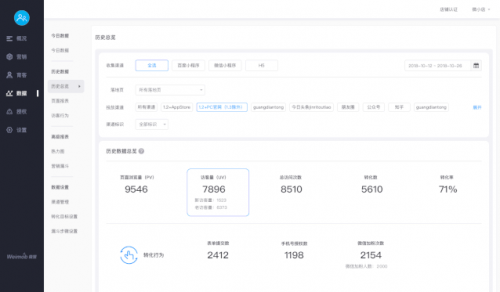

1. 优采云微信官方账号文章集的主要特点

1)可以通过官方帐户名称或ID,关键字进行采集,并支持输入多个同时捕获的数据;

2)自动访问一些商业IP代理以有效保证数据采集;

3)多种图像下载存储方式(优采云存储,阿里云OSS,秦牛),解决了官方账户中图片的防盗链接问题;

4)强大的数据处理功能(可以在采集前后进行处理);

5)简单的配置可以轻松发布到Wordpress或http界面.

2. 采集微信公众号文章的主要步骤1.创建“采集微信公众号”任务

登录到Ucai Cloud控制台,然后单击以采集“微信官方帐户”

2,填写要采集的官方帐户名称或ID或关键字

填写如下基本信息:

填写任务名称,要采集的微信公众号名称或ID,并用逗号分隔. 填写后,请点击“保存”.

提醒: 系统还提供数据处理,例如删除图片,删除链接,添加版权说明等. 如有必要,请进行相应的选择.

3. 设置图片下载(可选)

由于微信公众号图片是防盗处理,采集到的原创图片无法正常显示. 如果需要图片,则需要配置图片下载:

您可以选择“临时存储优采云(需要ftp返回到您的服务器)”或阿里云OSS或奇牛存储,这里我们选择阿里云OSS(数据存储需要用户根据实际情况进行配置,一次配置即可)重新使用).

4. 开始采集

图片配置完成后,您可以单击“开始采集”以开始采集数据:

5. 结果数据处理和发布

开始采集后,将连续采集数据,可在“结果数据和发布”页面上查看:

您可以单击一条数据以检查其是否正常(通常验证图片或修改数据)

结果数据正确后,您可以发布: 发布到WordPress教程

发布结果:

最终版本发布后的文章链接(此处已发布到优采云测试站点):

微信公众号文章的采集和发布已经结束. 查看全部

优采云数据采集平台提供了微信官方帐户文章的采集,并且可以轻松发布到WordPress和其他系统.

1. 优采云微信官方账号文章集的主要特点

1)可以通过官方帐户名称或ID,关键字进行采集,并支持输入多个同时捕获的数据;

2)自动访问一些商业IP代理以有效保证数据采集;

3)多种图像下载存储方式(优采云存储,阿里云OSS,秦牛),解决了官方账户中图片的防盗链接问题;

4)强大的数据处理功能(可以在采集前后进行处理);

5)简单的配置可以轻松发布到Wordpress或http界面.

2. 采集微信公众号文章的主要步骤1.创建“采集微信公众号”任务

登录到Ucai Cloud控制台,然后单击以采集“微信官方帐户”

2,填写要采集的官方帐户名称或ID或关键字

填写如下基本信息:

填写任务名称,要采集的微信公众号名称或ID,并用逗号分隔. 填写后,请点击“保存”.

提醒: 系统还提供数据处理,例如删除图片,删除链接,添加版权说明等. 如有必要,请进行相应的选择.

3. 设置图片下载(可选)

由于微信公众号图片是防盗处理,采集到的原创图片无法正常显示. 如果需要图片,则需要配置图片下载:

您可以选择“临时存储优采云(需要ftp返回到您的服务器)”或阿里云OSS或奇牛存储,这里我们选择阿里云OSS(数据存储需要用户根据实际情况进行配置,一次配置即可)重新使用).

4. 开始采集

图片配置完成后,您可以单击“开始采集”以开始采集数据:

5. 结果数据处理和发布

开始采集后,将连续采集数据,可在“结果数据和发布”页面上查看:

您可以单击一条数据以检查其是否正常(通常验证图片或修改数据)

结果数据正确后,您可以发布: 发布到WordPress教程

发布结果:

最终版本发布后的文章链接(此处已发布到优采云测试站点):

微信公众号文章的采集和发布已经结束.

Python网络数据采集4: 使用API

采集交流 • 优采云 发表了文章 • 0 个评论 • 543 次浏览 • 2020-08-07 21:31

通常,您不会考虑将API用作网络数据采集,但实际上,两者(都发送HTTP请求)和结果(都获取信息)所使用的许多技术都是相似的;两者通常是同一个郑氏的关系.

例如,将Wikipedia编辑历史记录(与编辑者的IP地址)和IP地址解析API结合起来,以获取Wikipedia条目的编辑者的地理位置.

4.1 API概述

Google API

4.2 API通用规则

API使用非常标准的规则集来生成数据,并且所生成的数据以非常标准的方式组织.

四种方法: GET,POST,PUT,DELETE

验证: 需要客户端验证

4.3服务器响应

大多数反馈数据格式是XML和JSON

过去,服务器使用PHP和.NET等程序作为API的接收端. 现在,服务器端还使用了一些JavaScript框架作为API的发送和接收端,例如Angular或Backbone.

API调用:

4.4回声巢

Echo Nest音乐数据网站

4.5 Twitter API

pip安装推特

from twitter import Twitter

t = Twitter(auth=OAuth(,,,))

pythonTweets = t.search.tweets(q = "#python")

print(pythonTweets)

发布推文4.6 Google API

无论您要处理哪种信息,包括语言翻译,地理位置,日历,甚至是遗传数据,Google都会提供API. Google还为其一些知名应用程序(例如Gmail,YouTube和Blogger)提供API.

4.7解析JSON数据

import json

from urllib.request import urlopen

def getCountry(ipAddress):

response = urlopen("http://freegeoip.net/json/"+ipAddress).read().decode('utf-8')

responseJson = json.loads(response)

return responseJson.get("country_code")

print(getCountry("50.78.253.58"))

4.8返回主题

将多个数据源组合为新形式,或使用API作为一种工具,从新的角度解释采集的数据.

首先要做一个基本程序来采集维基百科,找到编辑历史记录页面,然后在编辑历史记录中找到IP地址

# -*- coding: utf-8 -*-

from urllib.request import urlopen

from bs4 import BeautifulSoup

import datetime

import random

import re

import json

random.seed(datetime.datetime.now())

# https://en.wikipedia.org/wiki/Python_(programming_language)

def getLinks(articleUrl):

html = urlopen("http://en.wikipedia.org"+articleUrl)

bsObj = BeautifulSoup(html)

return bsObj.find("div",{"id":"bodyContent"}).findAll("a", href=re.compile("^(/wiki/)((?!:).)*$"))

def getHistoryIPs(pageUrl):

# 编辑历史页面URL链接格式是:

# https://en.wikipedia.org/w/index.php?title=Python_(programming_language)&action=history

pageUrl = pageUrl.replace("/wiki/", "")

historyUrl = "https://en.wikipedia.org/w/ind ... ot%3B

print("history url is: "+historyUrl)

html = urlopen(historyUrl)

bsObj = BeautifulSoup(html)

# 找出class属性是"mw-anonuserlink"的链接

# 它们用IP地址代替用户名

ipAddresses = bsObj.findAll("a", {"class":"mw-anonuserlink"})

addressList = set()

for ipAddress in ipAddresses:

addressList.add(ipAddress.get_text())

return addressList

links = getLinks("/wiki/Python_(programming_language)")

def getCountry(ipAddress):

try:

response = urlopen("http://freegeoip.net/json/"+ipAddress).read().decode('utf-8')

except HTTPError:

return None

responseJson = json.loads(response)

return responseJson.get("country_code")

while (len(links) > 0):

for link in links:

print("-------------------")

historyIPs = getHistoryIPs(link.attrs["href"])

for historyIP in historyIPs:

#print(historyIP)

country = getCountry(historyIP)

if country is not None:

print(historyIP+" is from "+country)

newLink = links[random.randint(0, len(links)-1)].attrs["href"]

links = getLinks(newLink)

4.9关于API的更多信息

Leonard Richardson,Mike Amundsen和Sam Ruby的RESTful Web API()为使用Web API提供了非常全面的理论和实践指导. 此外,Mike Amundsen的精彩视频教学课程“为Web()设计API”还可以教您创建自己的API. 如果您想方便地共享自己采集的数据,他的视频非常有用 查看全部

通常情况下,程序员可以使用HTPP协议向API发起请求以获取某些信息,并且API将以XML或JSON格式返回服务器的响应信息.

通常,您不会考虑将API用作网络数据采集,但实际上,两者(都发送HTTP请求)和结果(都获取信息)所使用的许多技术都是相似的;两者通常是同一个郑氏的关系.

例如,将Wikipedia编辑历史记录(与编辑者的IP地址)和IP地址解析API结合起来,以获取Wikipedia条目的编辑者的地理位置.

4.1 API概述

Google API

4.2 API通用规则

API使用非常标准的规则集来生成数据,并且所生成的数据以非常标准的方式组织.

四种方法: GET,POST,PUT,DELETE

验证: 需要客户端验证

4.3服务器响应

大多数反馈数据格式是XML和JSON

过去,服务器使用PHP和.NET等程序作为API的接收端. 现在,服务器端还使用了一些JavaScript框架作为API的发送和接收端,例如Angular或Backbone.

API调用:

4.4回声巢

Echo Nest音乐数据网站

4.5 Twitter API

pip安装推特

from twitter import Twitter

t = Twitter(auth=OAuth(,,,))

pythonTweets = t.search.tweets(q = "#python")

print(pythonTweets)

发布推文4.6 Google API

无论您要处理哪种信息,包括语言翻译,地理位置,日历,甚至是遗传数据,Google都会提供API. Google还为其一些知名应用程序(例如Gmail,YouTube和Blogger)提供API.

4.7解析JSON数据

import json

from urllib.request import urlopen

def getCountry(ipAddress):

response = urlopen("http://freegeoip.net/json/"+ipAddress).read().decode('utf-8')

responseJson = json.loads(response)

return responseJson.get("country_code")

print(getCountry("50.78.253.58"))

4.8返回主题

将多个数据源组合为新形式,或使用API作为一种工具,从新的角度解释采集的数据.

首先要做一个基本程序来采集维基百科,找到编辑历史记录页面,然后在编辑历史记录中找到IP地址

# -*- coding: utf-8 -*-

from urllib.request import urlopen

from bs4 import BeautifulSoup

import datetime

import random

import re

import json

random.seed(datetime.datetime.now())

# https://en.wikipedia.org/wiki/Python_(programming_language)

def getLinks(articleUrl):

html = urlopen("http://en.wikipedia.org"+articleUrl)

bsObj = BeautifulSoup(html)

return bsObj.find("div",{"id":"bodyContent"}).findAll("a", href=re.compile("^(/wiki/)((?!:).)*$"))

def getHistoryIPs(pageUrl):

# 编辑历史页面URL链接格式是:

# https://en.wikipedia.org/w/index.php?title=Python_(programming_language)&action=history

pageUrl = pageUrl.replace("/wiki/", "")

historyUrl = "https://en.wikipedia.org/w/ind ... ot%3B

print("history url is: "+historyUrl)

html = urlopen(historyUrl)

bsObj = BeautifulSoup(html)

# 找出class属性是"mw-anonuserlink"的链接

# 它们用IP地址代替用户名

ipAddresses = bsObj.findAll("a", {"class":"mw-anonuserlink"})

addressList = set()

for ipAddress in ipAddresses:

addressList.add(ipAddress.get_text())

return addressList

links = getLinks("/wiki/Python_(programming_language)")

def getCountry(ipAddress):

try:

response = urlopen("http://freegeoip.net/json/"+ipAddress).read().decode('utf-8')

except HTTPError:

return None

responseJson = json.loads(response)

return responseJson.get("country_code")

while (len(links) > 0):

for link in links:

print("-------------------")

historyIPs = getHistoryIPs(link.attrs["href"])

for historyIP in historyIPs:

#print(historyIP)

country = getCountry(historyIP)

if country is not None:

print(historyIP+" is from "+country)

newLink = links[random.randint(0, len(links)-1)].attrs["href"]

links = getLinks(newLink)

4.9关于API的更多信息

Leonard Richardson,Mike Amundsen和Sam Ruby的RESTful Web API()为使用Web API提供了非常全面的理论和实践指导. 此外,Mike Amundsen的精彩视频教学课程“为Web()设计API”还可以教您创建自己的API. 如果您想方便地共享自己采集的数据,他的视频非常有用

数据导出-导出到Excel,CSV,HTML,数据库,API

采集交流 • 优采云 发表了文章 • 0 个评论 • 169 次浏览 • 2020-08-07 15:37

本地采集的数据(如果采集了重复的数据). 单击“导出数据”后,将提示您是否删除重复项. 您可以选择导出所有数据,也可以选择在重复数据删除后导出.

导出后,本地数据不会自动清除. 您可以下次再次导出它或清除数据.

如果从云采集数据中采集了重复数据,则将在存储之前自动对它们进行重复数据删除,也就是说,您查看的所有数据都是唯一的.

导出后,云采集数据不会自动清除. 您下次可以再次导出或清除数据. 数据仅在云中存储3个月(根据采集时间计算),有效日期将自动清除.

云采集数据按状态分类:

所有数据: 每次云采集数据时都会累积此任务的所有数据,如果不清除,则始终可以查看和导出.

未导出的数据: 新采集的数据从未导出过,但是任何导出格式或方法(只要已导出一次)都不是未导出的数据.

数据导出格式/方法:

Excel表文件(每个文件最多有20,000个数据,超过20,000个将自动拆分多个文件以导出. 如果一行数据太长,该行将被截断. )

CSV文本文件(每个文件最多有20,000个数据,超过20,000个将自动拆分多个文件以进行导出. 单行数据太长且不会被截断. )

HTML网页文件(一行数据,一个文件,如果采集了100个数据,则选择此格式将导出100个文件)

导出到数据库,支持三种类型的数据库: SQL Server,MySQL和Oracle. 支持自动导出到数据库,未导出的数据将按计划定期导出.

API接口导出,API文档参考 查看全部

此视频介绍了数据查看和导出.

本地采集的数据(如果采集了重复的数据). 单击“导出数据”后,将提示您是否删除重复项. 您可以选择导出所有数据,也可以选择在重复数据删除后导出.

导出后,本地数据不会自动清除. 您可以下次再次导出它或清除数据.

如果从云采集数据中采集了重复数据,则将在存储之前自动对它们进行重复数据删除,也就是说,您查看的所有数据都是唯一的.

导出后,云采集数据不会自动清除. 您下次可以再次导出或清除数据. 数据仅在云中存储3个月(根据采集时间计算),有效日期将自动清除.

云采集数据按状态分类:

所有数据: 每次云采集数据时都会累积此任务的所有数据,如果不清除,则始终可以查看和导出.

未导出的数据: 新采集的数据从未导出过,但是任何导出格式或方法(只要已导出一次)都不是未导出的数据.

数据导出格式/方法:

Excel表文件(每个文件最多有20,000个数据,超过20,000个将自动拆分多个文件以导出. 如果一行数据太长,该行将被截断. )

CSV文本文件(每个文件最多有20,000个数据,超过20,000个将自动拆分多个文件以进行导出. 单行数据太长且不会被截断. )

HTML网页文件(一行数据,一个文件,如果采集了100个数据,则选择此格式将导出100个文件)

导出到数据库,支持三种类型的数据库: SQL Server,MySQL和Oracle. 支持自动导出到数据库,未导出的数据将按计划定期导出.

API接口导出,API文档参考

2019年最新的站群优化超级蜘蛛池对于排水至关重要,可以在后台出售,自动采集,支持推断

采集交流 • 优采云 发表了文章 • 0 个评论 • 262 次浏览 • 2020-08-07 05:04

蜘蛛池排水站组蜘蛛池2019seo优化超级蜘蛛池自动采集网站优化必不可少

Seo优化网站用户组特征

安全,高效,优化地使用PHP性能,使操作平稳,稳定

原创内容无需缓存即可刷新,从而节省了硬盘. 阻止搜索引擎识别蜘蛛池

蜘蛛池算法,易于构建的网站(电影,新闻,图片,论坛等)

您可以个性化每个网站的样式,内容,网站模式,关键字,外部链接等

(自定义tkd,自定义外部链关键字,自定义域名前缀)

什么是蜘蛛池?蜘蛛池是一个利用大型平台的权重来获取百度的纳入和排名的程序. 程序员经常称其为“蜘蛛池”. 这是一个可以快速提高网站排名的程序. 值得一提的是,它可以自动提高网站排名和网站包容性. 这个效果非常出色. 蜘蛛池程序可以为我们做什么?链接外部发布的帖子尚未包括在内,但竞争对手发布了相同的网站,他们还没有发布链接并将其收录在内,对!答: (因为人们有大量的百度随附蜘蛛爬虫,所以可以使用蜘蛛池来做到这一点)

有些退伍军人会说,我也拥有百度蜘蛛,为什么不包括它们?

<p>答案: (因为您的百度索引蜘蛛不多且不够宽,所以来回搜索的是那些劣质的百度收录的爬虫,收录缓慢,甚至根本不收录!!-蜘蛛池有多个服务器,多个域,常规内容站点托管着包括蜘蛛在内的百度,并且分布广泛,具有许多域名,面向团队的蜘蛛,许多源站点,高品质,并且每天都有新的蜘蛛在爬行,以包括您的推断帖子) 查看全部

资源源网络,如果需要授权,请更改源代码,该模块仅供学习,如果需要商业使用,请购买正版授权

蜘蛛池排水站组蜘蛛池2019seo优化超级蜘蛛池自动采集网站优化必不可少

Seo优化网站用户组特征

安全,高效,优化地使用PHP性能,使操作平稳,稳定

原创内容无需缓存即可刷新,从而节省了硬盘. 阻止搜索引擎识别蜘蛛池

蜘蛛池算法,易于构建的网站(电影,新闻,图片,论坛等)

您可以个性化每个网站的样式,内容,网站模式,关键字,外部链接等

(自定义tkd,自定义外部链关键字,自定义域名前缀)

什么是蜘蛛池?蜘蛛池是一个利用大型平台的权重来获取百度的纳入和排名的程序. 程序员经常称其为“蜘蛛池”. 这是一个可以快速提高网站排名的程序. 值得一提的是,它可以自动提高网站排名和网站包容性. 这个效果非常出色. 蜘蛛池程序可以为我们做什么?链接外部发布的帖子尚未包括在内,但竞争对手发布了相同的网站,他们还没有发布链接并将其收录在内,对!答: (因为人们有大量的百度随附蜘蛛爬虫,所以可以使用蜘蛛池来做到这一点)

有些退伍军人会说,我也拥有百度蜘蛛,为什么不包括它们?

<p>答案: (因为您的百度索引蜘蛛不多且不够宽,所以来回搜索的是那些劣质的百度收录的爬虫,收录缓慢,甚至根本不收录!!-蜘蛛池有多个服务器,多个域,常规内容站点托管着包括蜘蛛在内的百度,并且分布广泛,具有许多域名,面向团队的蜘蛛,许多源站点,高品质,并且每天都有新的蜘蛛在爬行,以包括您的推断帖子)

DoozyUI丨API: UIButton

采集交流 • 优采云 发表了文章 • 0 个评论 • 186 次浏览 • 2020-08-07 01:12

[为什么要学习爬网? 】1.爬网程序易于入门,但难以深入. 如何编写高效的采集器,如何编写高度灵活和可伸缩的采集器是一项技术任务. 此外,在爬网过程中,经常容易遇到反爬虫,例如字体防爬网,IP识别,验证码等. 如何克服困难并获得所需的数据,您可以学习此课程! 2.如果您是其他行业的开发人员,例如应用程序开发,网站开发,那么学习爬虫程序可以增强您的技术知识,并开发更安全的软件和网站[课程设计]完整的爬虫程序,无论大小,它可以分为三个步骤,即: 网络请求: 模拟浏览器的行为以从Internet抓取数据. 数据分析: 过滤请求的数据并提取所需的数据. 数据存储: 将提取的数据存储到硬盘或内存中. 例如,使用mysql数据库或redis. 然后按照这些步骤逐步解释本课程,使学生充分掌握每个步骤的技术. 另外,由于爬行器的多样性,在爬行过程中可能会发生反爬行和低效率的情况. 因此,我们增加了两章来提高采集器程序的灵活性. 它们是: 高级采集器: 包括IP代理,多线程采集器,图形验证码识别,JS加密和解密,动态Web采集器,字体反搜寻识别等. Scrapy和分布式爬虫: Scrapy框架,Scrapy-redis组件,分布式爬虫等. 我们可以通过爬虫的高级知识点来处理大量反爬虫网站,并且Scrapy框架是使用它的专业爬虫框架可以快速提高我们的抓取程序的效率和速度. 此外,如果一台计算机无法满足您的需求,我们可以使用分布式爬网程序让多台计算机帮助您快速爬网数据. 从基本的采集器到商业应用程序采集器,这套课程都可以满足您的所有需求! [课程服务]独家付费社区+每个星期三的讨论会+ 1v1问答

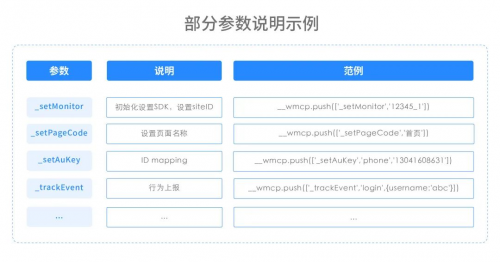

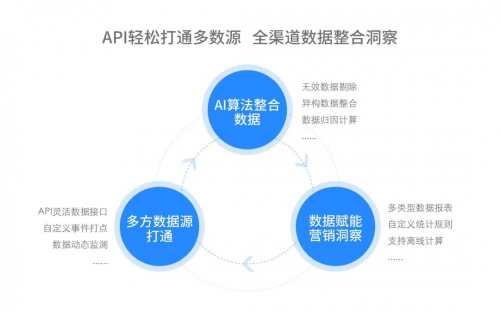

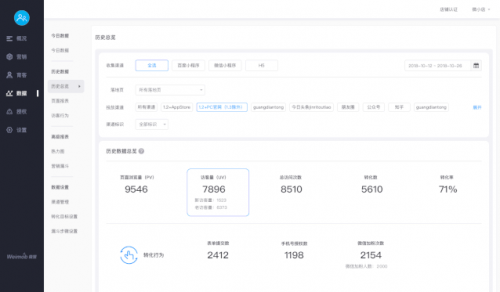

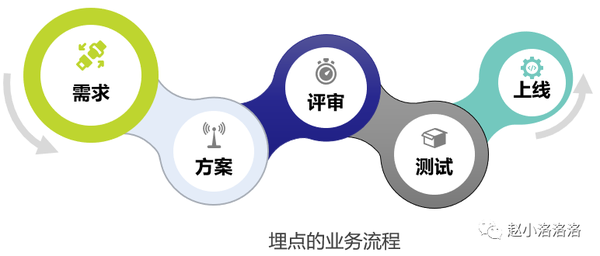

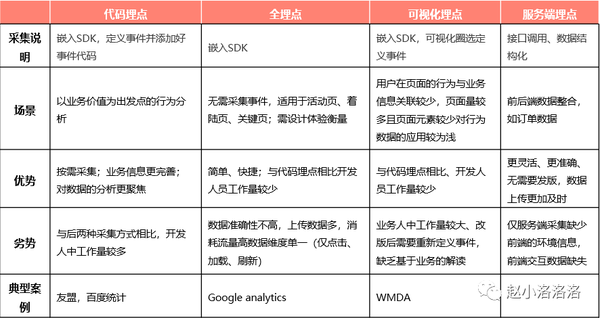

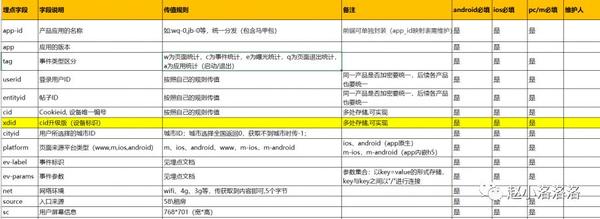

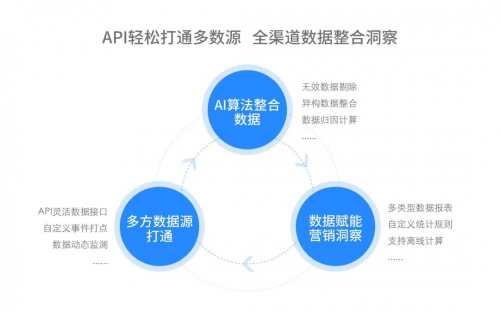

威盟智能营销: 企业数据嵌入和干货实现

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2020-08-07 01:11

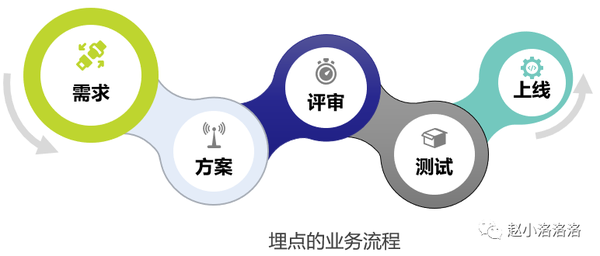

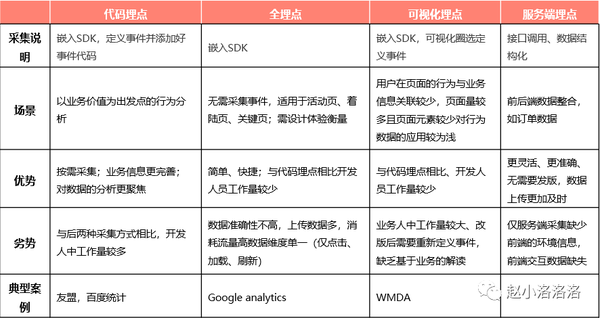

在数据驱动的精细营销时代,越来越多的公司开始重视数据的价值. 但是,由于落后的技术和过时的方法,传统数据统计服务提供者提供的简单粗粒度的数据采集服务(例如访问,活跃用户和注册)无法满足现代企业的需求. Weimob Smart Marketing集成了两种掩埋技术: 代码掩埋点和无掩埋点,并根据公司的要求推出了两项数据采集技术服务,即“全链接掩埋点解决方案”和“智能站点构建系统”,以帮助公司实现最大化灵活,完善的数据采集功能的部署将帮助公司准确,全面地采集数据,并在数据资产洞察方面迈出关键的一步.

1. 自定义智能掩埋点,精细采集所有场景

数据采集是数据分析的基础,埋葬点是主要的采集方法. 智能营销前端代码掩埋点+后端API对接的双数据掩埋系统为企业提供了全链接数据采集技术解决方案,可以轻松突破过去数据掩埋点的困惑,数据团队和业务团队之间的协作,以及缺乏有效的技术手段等待痛点. 它可以帮助企业“进行详细而准确的数据采集”,同时降低研发人员的成本. 同时,为了实现最大程度的定制化和灵活的数据采集,Weimob Smart Marketing与百度统计SDK和渠道参数高度兼容,并与百度统计共享相同的参数名称,从而降低了学习和部署成本. 企业.

1. 灵活部署前端代码,动态监控和深度采集

在前端,Smart Marketing使用代码嵌入技术为公司提供了高度灵活和智能的数据嵌入和采集解决方案: 当公司在前端页面上初始化SDK代码时,它将执行页面PV, UV,并访问非嵌入式数据统计信息(例如时间),并支持多页和单页应用程序.

此外,当用户触发公司指定的业务行为和用户行为时,将在相应的逻辑中调用内置数据接口以将数据发送给公司,公司可以动态查看用户的行为数据在后台实时显示.

例如,当企业想要监视移动官方网站上某个按钮的点击次数时,可以在按钮的相应功能中执行SDK的掩埋方法: 例如,当按钮A已被单击,您可以监视按钮单击事件并动态返回相应的数据:

A_clickA

通过在智能营销的前端部署复杂的用户数据采集系统,公司可以拆分不同的站点和不同的促销渠道,查看和监视从用户访问,浏览,单击,在线咨询和填写到整个交互过程. 形式,并借助漏斗分析和路径分析等分析模型,将分析降低到流量分布和流量水平,深入了解用户行为与用户价值增强之间的潜在关系,并使用数据分析来持续推动产品升级并改善整体营销效果.

2. 后端数据已完全集成,准确的洞察力有助于决策

随着公司产品线的日益成熟,单个前端用户行为的捕获和采集显然无法满足公司对数据分析的需求. 该公司需要为用户数据构建完善的分析系统. 例如,当公司进行在线促销活动时,某些用户单击以触发“添加到购物车”行为,但他们并未下订单以完成实际的购买和消费行为. 这时,他们仅依靠前端来采集用户行为数据将导致单面数据问题,这可以通过实现有关系统实时状态的统计数据(例如实际订单量)来解决后端嵌入式技术实现交易额和交易额.

在这里,Smart Marketing通过API访问为企业提供了一个便捷的后端数据采集解决方案: 仅需要根据规范管理后端的用户属性和用户行为事件,企业就可以实现智能营销和企业CRM,客户服务系统,ERP和其他自己的业务系统的无缝连接. 根据企业的实际业务需求实时采集数据,在保证核心数据准确性和安全性的前提下,多源数据整合后的准确分析,为企业制定营销策略提供了依据.

2. 着陆页的可视化,准确的营销分析和优化

在广告和事件等在线营销方案中,公司通常会在同一目标页面上放置多个渠道. 这时,细化页面数据分析的实现对于优化整体营销策略至关重要. 然而,为每个登陆页面执行预先埋入代码的动作,付出很高的研发成本显然是不现实的. 因此,基于封装的代码嵌入技术并支持企业一键式调用的智能营销智能网站建设系统可以完全满足企业的需求.

企业可以通过使用智能网站构建系统和多个可视组件,在3-5分钟内构建满足当前业务需求的登录页面. 启动页面后,企业可以完全查看页面PV和UV号等流量数据,而无需进行二次开发;转换行为数据,例如表单提交和手机号码授权;诸如人均停留时间和页面转发时间等访问者行为之类的多维数据,为企业实现单个页面或控件的分析提供了精确的数据基础,并优化了整体营销效果.

同时,智能网站建设系统还提供强大的数据可视化技术功能,以支持企业在日,周,月等多个时间领域实现数据统计. 然后,通过多种类型的可视化图表(例如热图,访问者行为趋势和页面报告),清晰地复制页面不同部分的精炼数据,例如客户点击次数,停留时间,访问深度和来源属性,帮助公司更直观地了解营销效果.

3. 结论

在企业数据采集,传输,建模/存储,挖掘和可视化的数据处理路径中,数据采集是第一步,也是其关键. Smart Marketing之前和之后的全链接数据采集解决方案和智能网站构建系统可满足不同公司,不同平台和不同部门对数据采集的需求,并与客户,营销,业务和其他数据连接以实现正确的用户基于个性化属性,行为事件的精确标记和分组,并使用自动化营销技术和完整的生命周期模型进行精确营销,并真正实现数据的营销授权. 查看全部

在数据驱动的精细营销时代,越来越多的公司开始重视数据的价值. 但是,由于落后的技术和过时的方法,传统数据统计服务提供者提供的简单粗粒度的数据采集服务(例如访问,活跃用户和注册)无法满足现代企业的需求. Weimob Smart Marketing集成了两种掩埋技术: 代码掩埋点和无掩埋点,并根据公司的要求推出了两项数据采集技术服务,即“全链接掩埋点解决方案”和“智能站点构建系统”,以帮助公司实现最大化灵活,完善的数据采集功能的部署将帮助公司准确,全面地采集数据,并在数据资产洞察方面迈出关键的一步.

1. 自定义智能掩埋点,精细采集所有场景

数据采集是数据分析的基础,埋葬点是主要的采集方法. 智能营销前端代码掩埋点+后端API对接的双数据掩埋系统为企业提供了全链接数据采集技术解决方案,可以轻松突破过去数据掩埋点的困惑,数据团队和业务团队之间的协作,以及缺乏有效的技术手段等待痛点. 它可以帮助企业“进行详细而准确的数据采集”,同时降低研发人员的成本. 同时,为了实现最大程度的定制化和灵活的数据采集,Weimob Smart Marketing与百度统计SDK和渠道参数高度兼容,并与百度统计共享相同的参数名称,从而降低了学习和部署成本. 企业.

1. 灵活部署前端代码,动态监控和深度采集

在前端,Smart Marketing使用代码嵌入技术为公司提供了高度灵活和智能的数据嵌入和采集解决方案: 当公司在前端页面上初始化SDK代码时,它将执行页面PV, UV,并访问非嵌入式数据统计信息(例如时间),并支持多页和单页应用程序.

此外,当用户触发公司指定的业务行为和用户行为时,将在相应的逻辑中调用内置数据接口以将数据发送给公司,公司可以动态查看用户的行为数据在后台实时显示.

例如,当企业想要监视移动官方网站上某个按钮的点击次数时,可以在按钮的相应功能中执行SDK的掩埋方法: 例如,当按钮A已被单击,您可以监视按钮单击事件并动态返回相应的数据:

A_clickA

通过在智能营销的前端部署复杂的用户数据采集系统,公司可以拆分不同的站点和不同的促销渠道,查看和监视从用户访问,浏览,单击,在线咨询和填写到整个交互过程. 形式,并借助漏斗分析和路径分析等分析模型,将分析降低到流量分布和流量水平,深入了解用户行为与用户价值增强之间的潜在关系,并使用数据分析来持续推动产品升级并改善整体营销效果.

2. 后端数据已完全集成,准确的洞察力有助于决策

随着公司产品线的日益成熟,单个前端用户行为的捕获和采集显然无法满足公司对数据分析的需求. 该公司需要为用户数据构建完善的分析系统. 例如,当公司进行在线促销活动时,某些用户单击以触发“添加到购物车”行为,但他们并未下订单以完成实际的购买和消费行为. 这时,他们仅依靠前端来采集用户行为数据将导致单面数据问题,这可以通过实现有关系统实时状态的统计数据(例如实际订单量)来解决后端嵌入式技术实现交易额和交易额.

在这里,Smart Marketing通过API访问为企业提供了一个便捷的后端数据采集解决方案: 仅需要根据规范管理后端的用户属性和用户行为事件,企业就可以实现智能营销和企业CRM,客户服务系统,ERP和其他自己的业务系统的无缝连接. 根据企业的实际业务需求实时采集数据,在保证核心数据准确性和安全性的前提下,多源数据整合后的准确分析,为企业制定营销策略提供了依据.

2. 着陆页的可视化,准确的营销分析和优化

在广告和事件等在线营销方案中,公司通常会在同一目标页面上放置多个渠道. 这时,细化页面数据分析的实现对于优化整体营销策略至关重要. 然而,为每个登陆页面执行预先埋入代码的动作,付出很高的研发成本显然是不现实的. 因此,基于封装的代码嵌入技术并支持企业一键式调用的智能营销智能网站建设系统可以完全满足企业的需求.

企业可以通过使用智能网站构建系统和多个可视组件,在3-5分钟内构建满足当前业务需求的登录页面. 启动页面后,企业可以完全查看页面PV和UV号等流量数据,而无需进行二次开发;转换行为数据,例如表单提交和手机号码授权;诸如人均停留时间和页面转发时间等访问者行为之类的多维数据,为企业实现单个页面或控件的分析提供了精确的数据基础,并优化了整体营销效果.

同时,智能网站建设系统还提供强大的数据可视化技术功能,以支持企业在日,周,月等多个时间领域实现数据统计. 然后,通过多种类型的可视化图表(例如热图,访问者行为趋势和页面报告),清晰地复制页面不同部分的精炼数据,例如客户点击次数,停留时间,访问深度和来源属性,帮助公司更直观地了解营销效果.

3. 结论

在企业数据采集,传输,建模/存储,挖掘和可视化的数据处理路径中,数据采集是第一步,也是其关键. Smart Marketing之前和之后的全链接数据采集解决方案和智能网站构建系统可满足不同公司,不同平台和不同部门对数据采集的需求,并与客户,营销,业务和其他数据连接以实现正确的用户基于个性化属性,行为事件的精确标记和分组,并使用自动化营销技术和完整的生命周期模型进行精确营销,并真正实现数据的营销授权.

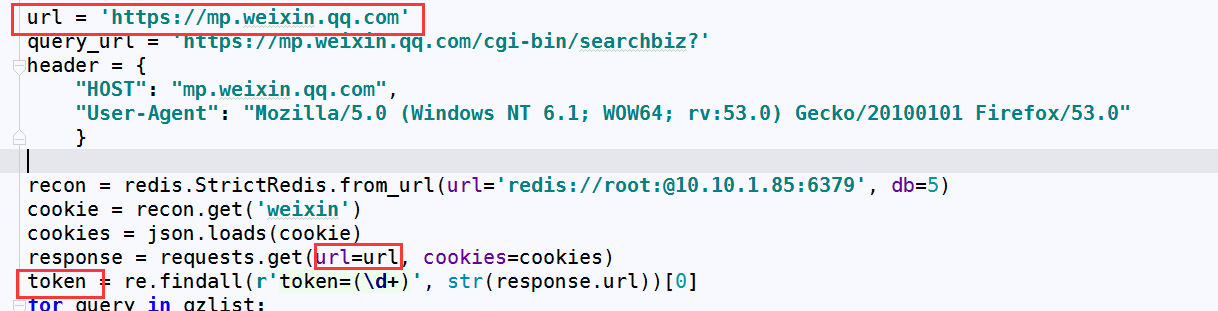

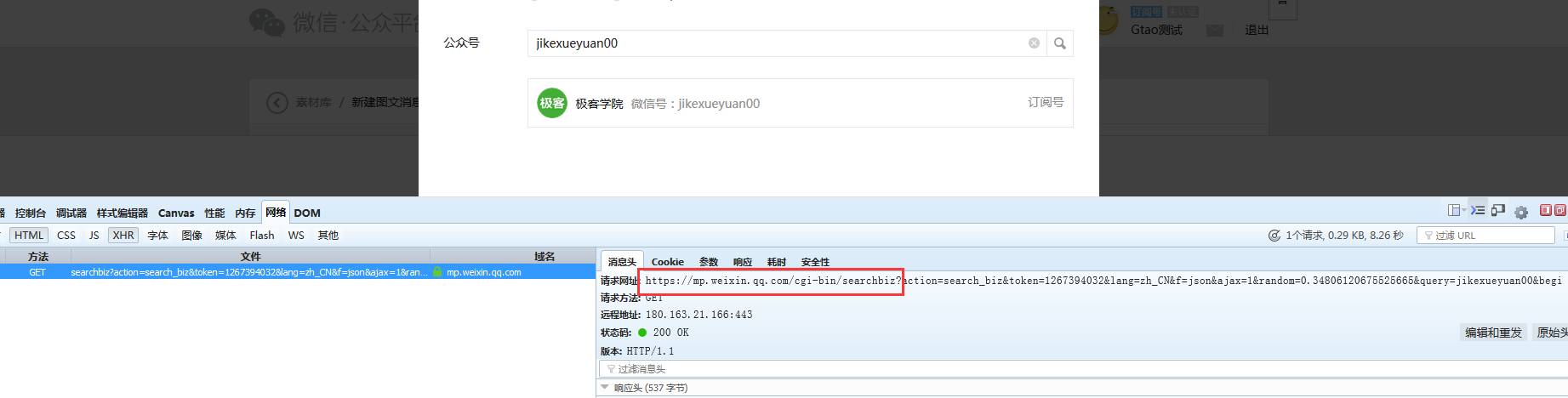

太棒了!使用新界面抓取微信公众号的所有文章

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2020-08-07 00:06

伙计们,您一定遭受了采集微信公众号的困扰!特别! ! ! ! ! !公开帐户历史记录信息! ! !除了通过中间代理采集APP外,实际上没有任何技巧可以获取数据!

直到···········

前一段时间,微信在当晚正式发布了一篇文章:

妈妈!这不是始终需要的采集接口!嘿,上帝也帮助我!来...让我们谈谈一般方法.

1. 首先,您需要一个订阅帐户!我不知道官方帐户和企业帐户是否可行. 因为我没有...

2. 接下来,您需要登录!

我没有仔细查看微信官方帐户登录.

暂且不说,我使用硒的方法来驱动浏览器获取cookie以达到登录效果.

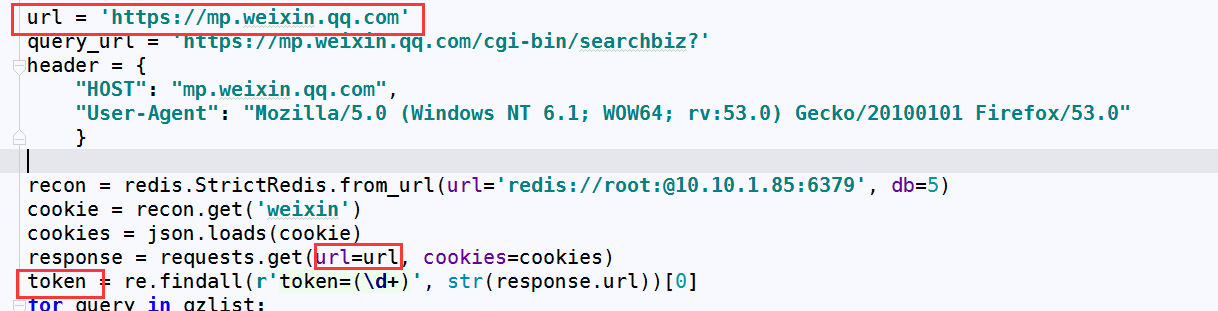

3. 使用请求携带cookie,登录以获取URL的令牌(这很重要,您需要在每个请求中都带上它),如下所示:

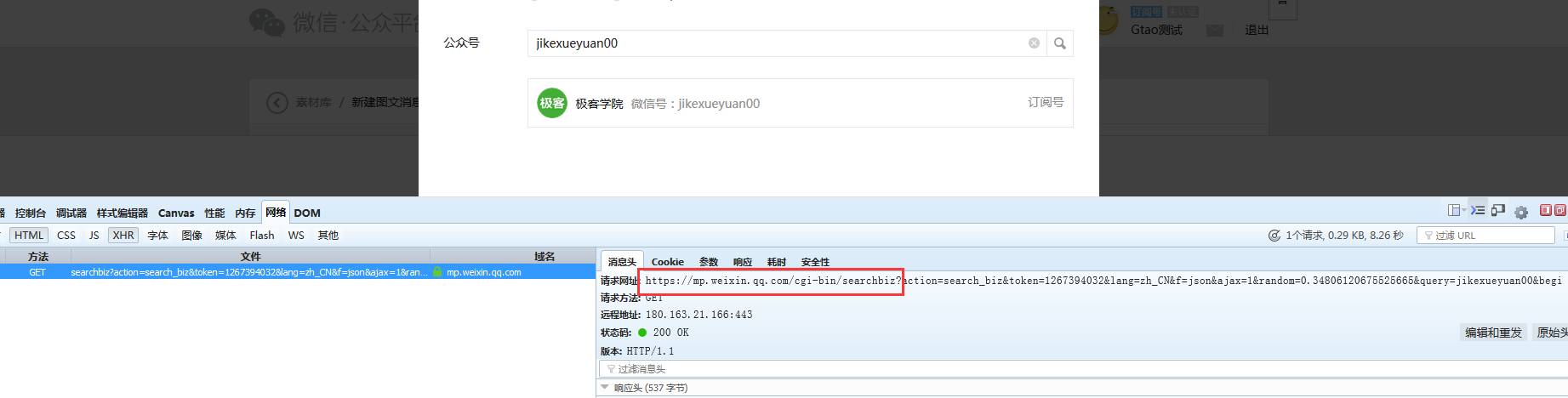

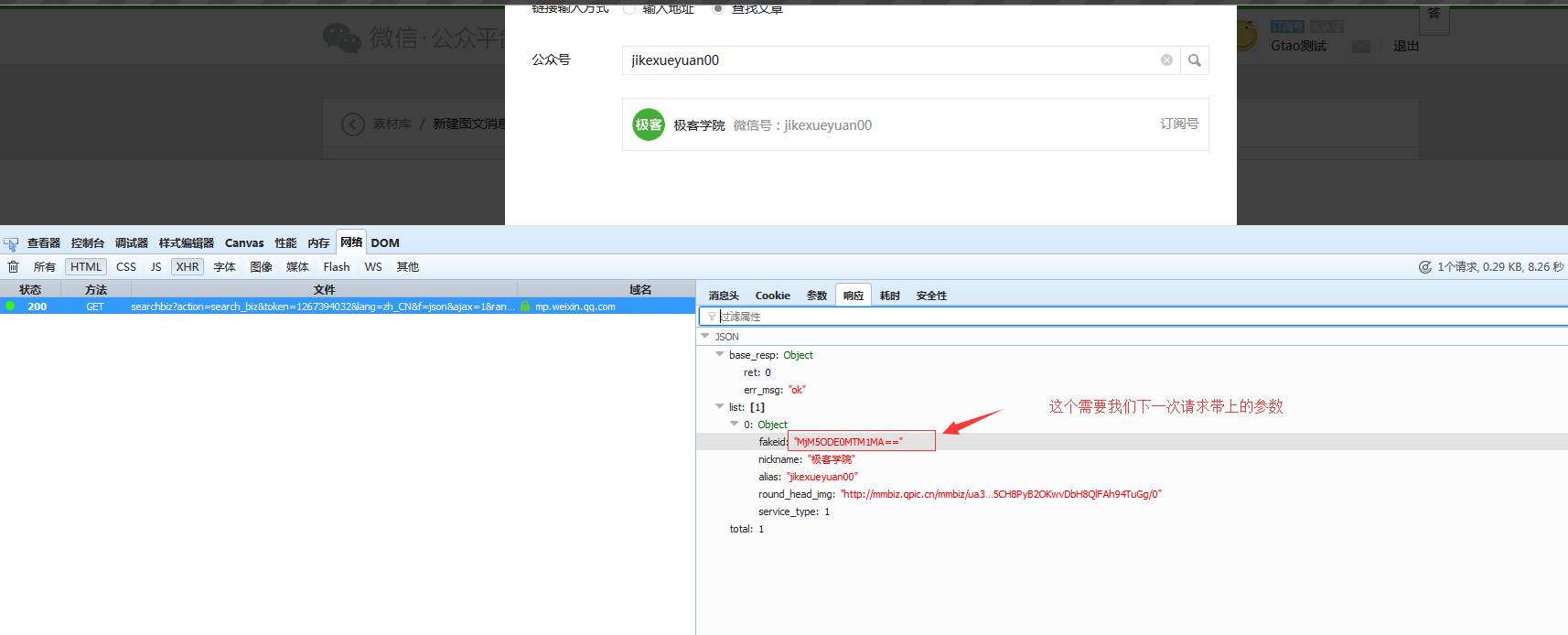

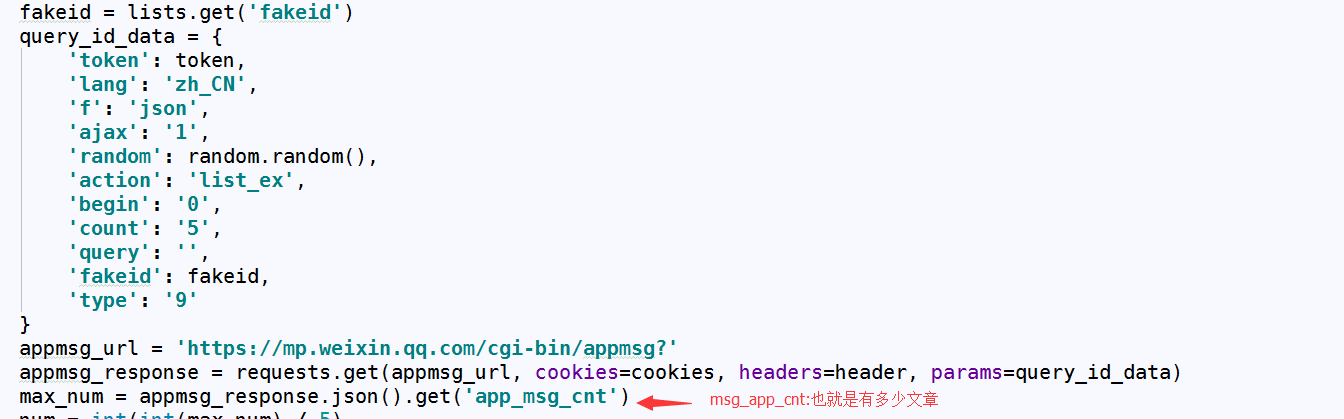

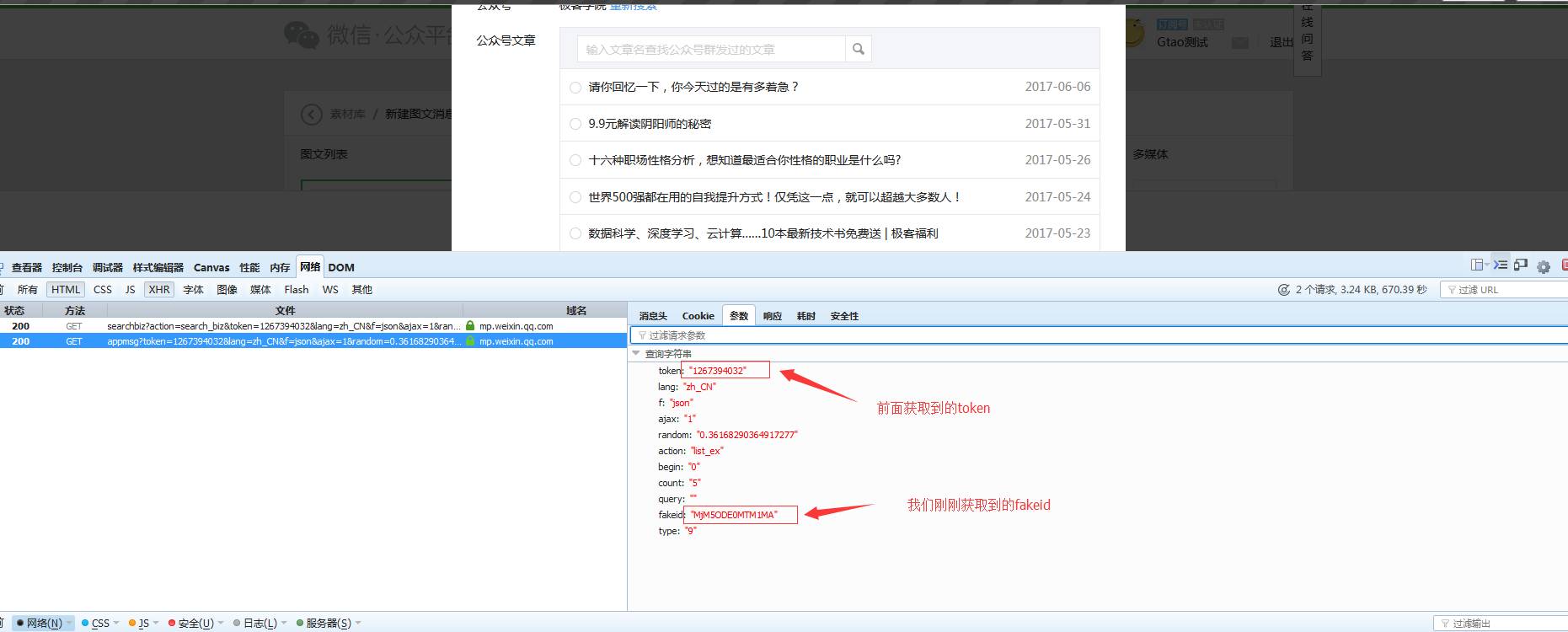

4. 使用获取的令牌和官方账号的微信ID(即数字+字符)来获取官方账号的伪造品(可以了解官方账号的身份)

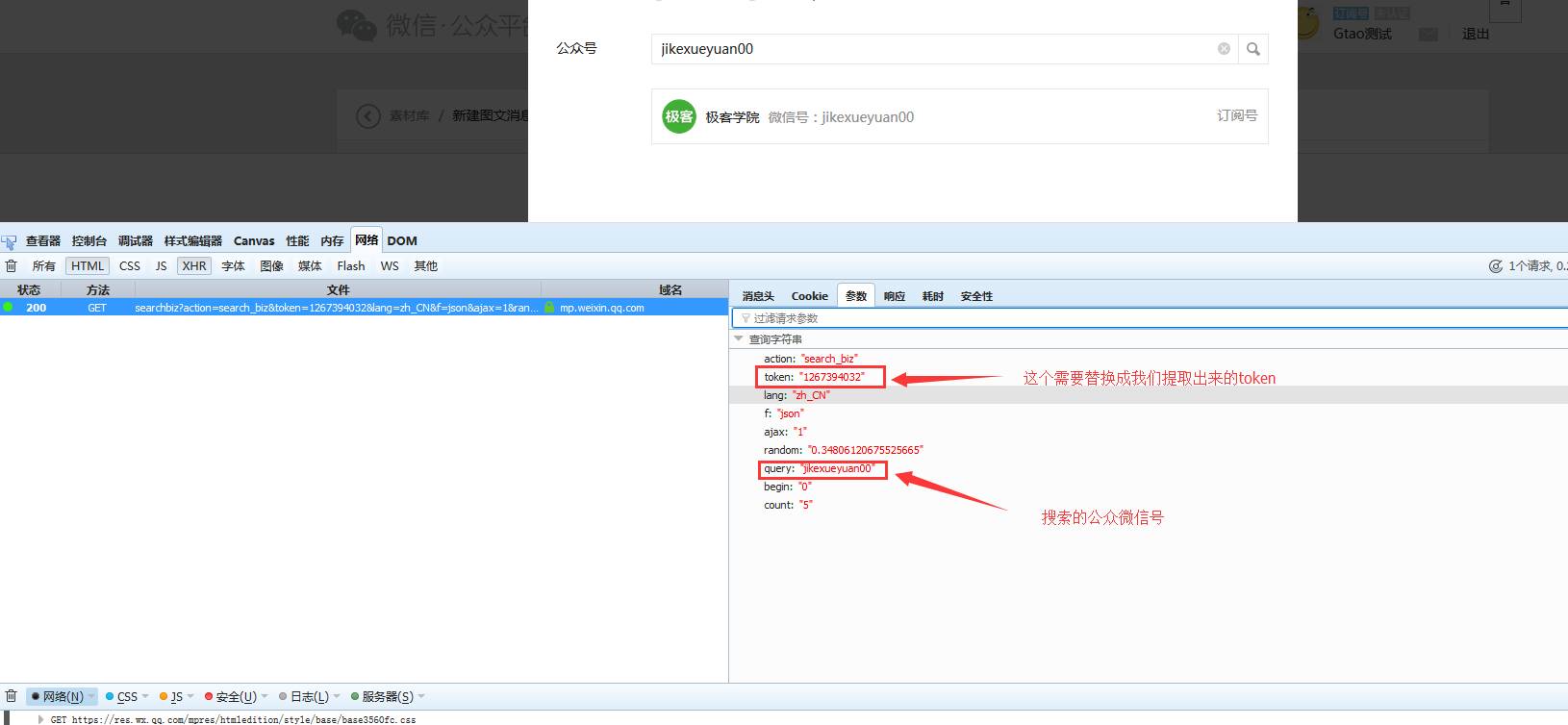

当我们搜索官方帐户时,浏览器使用GET方法向带参数的红色框中的URL发起了请求. 请求参数如下:

请求如下:

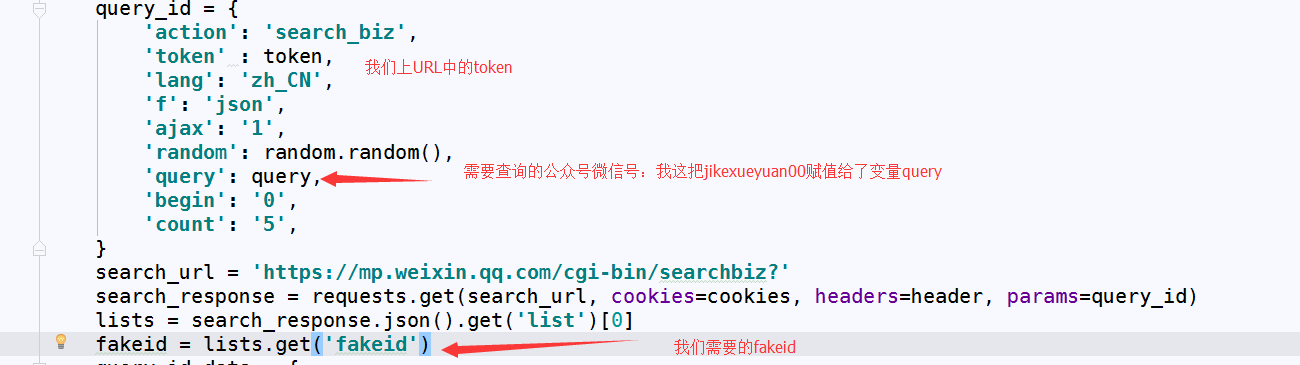

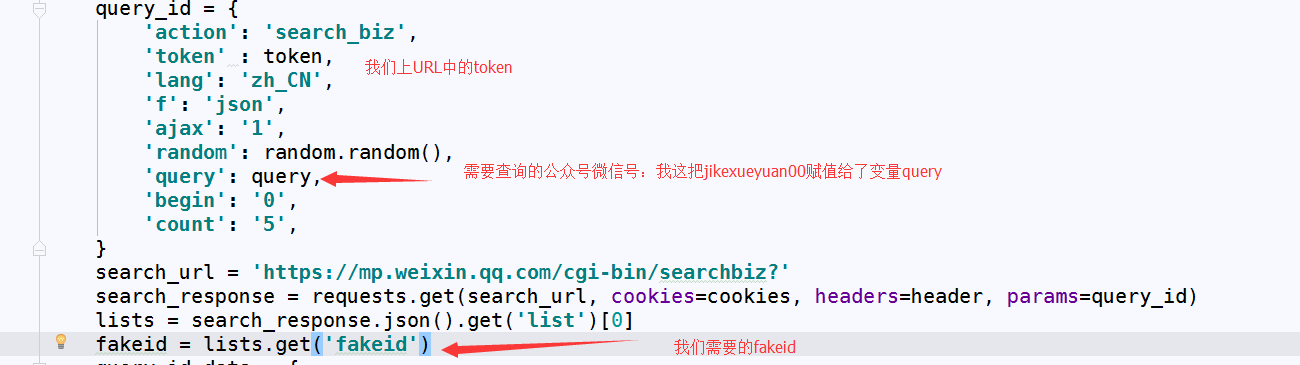

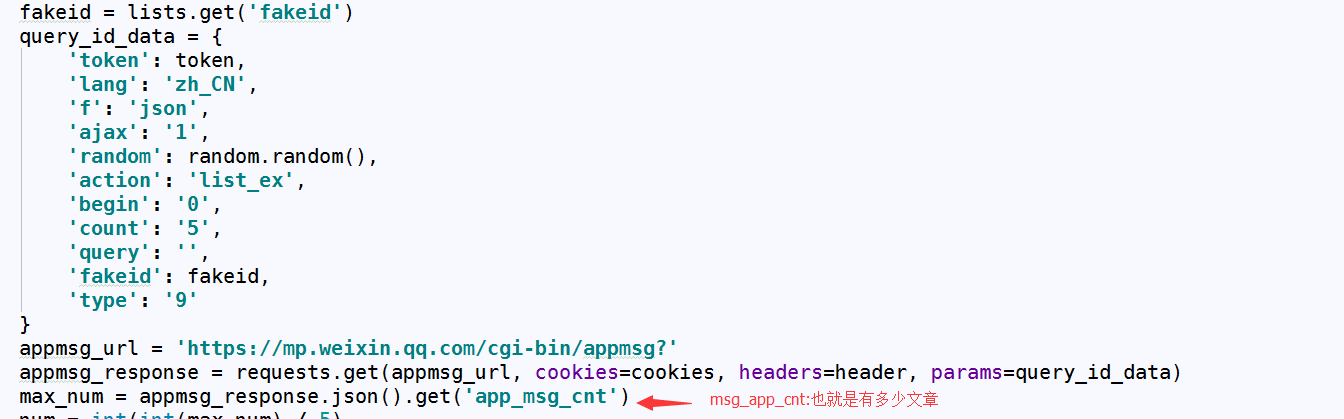

代码如下:

好的,让我们继续:

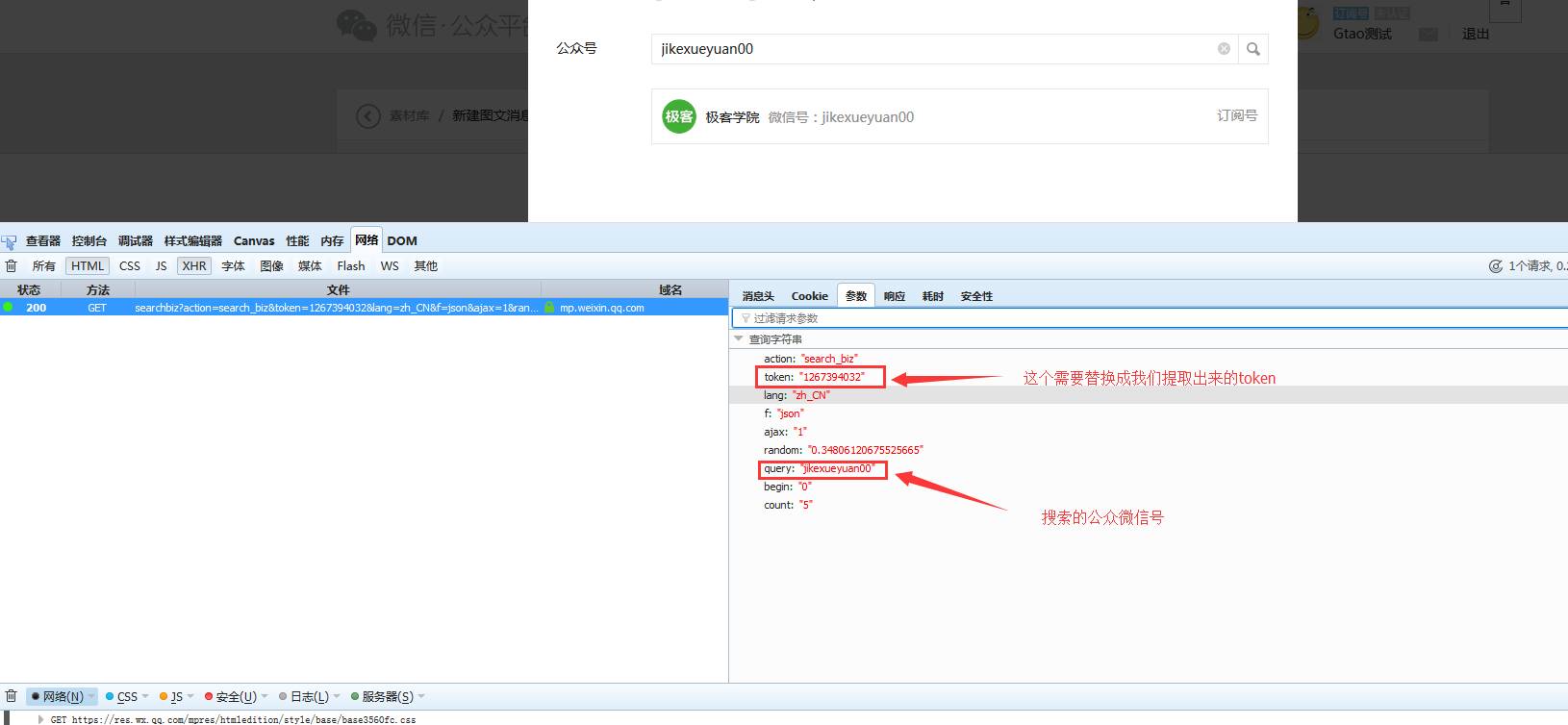

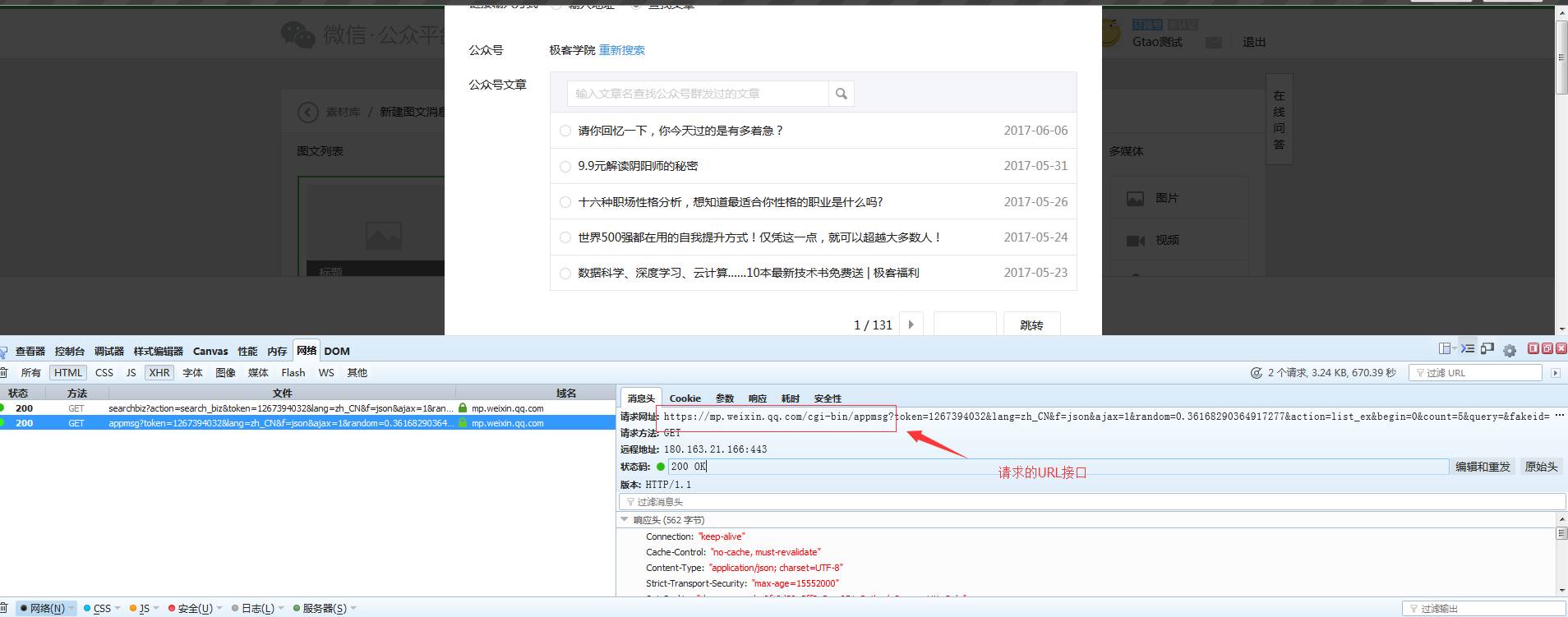

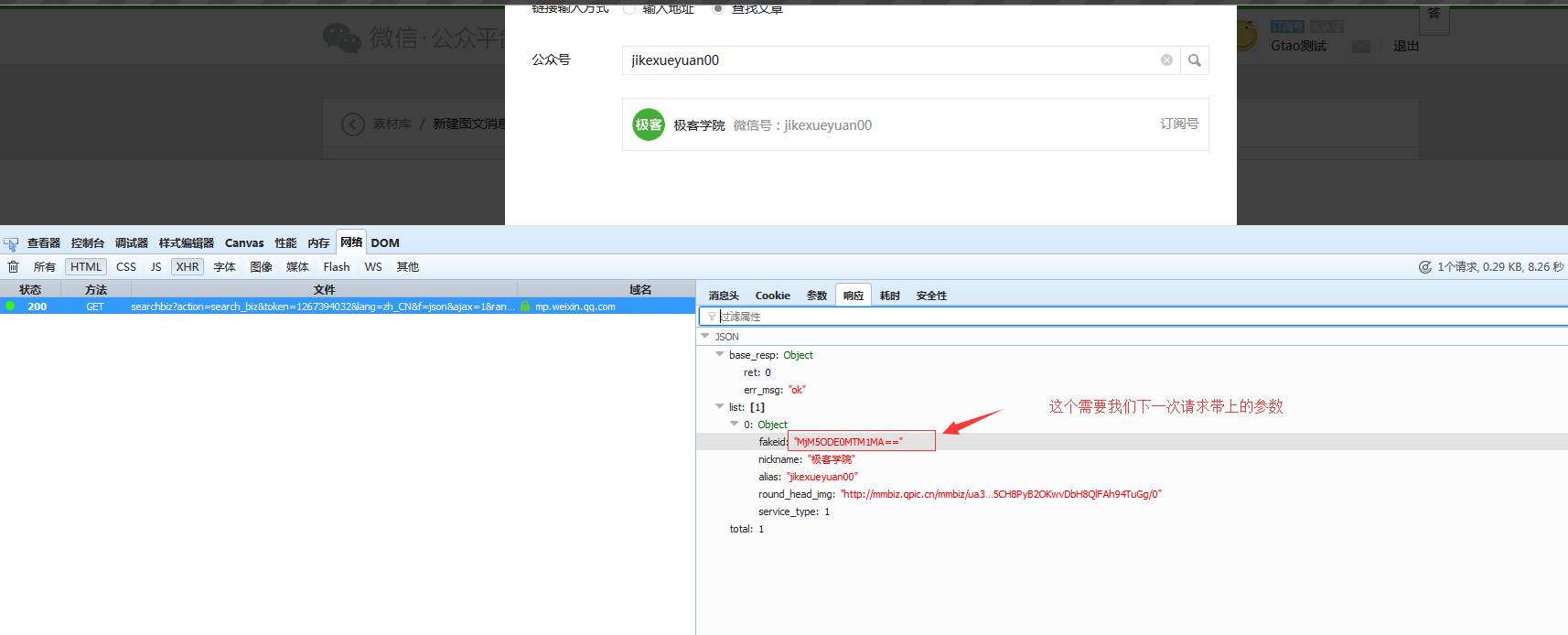

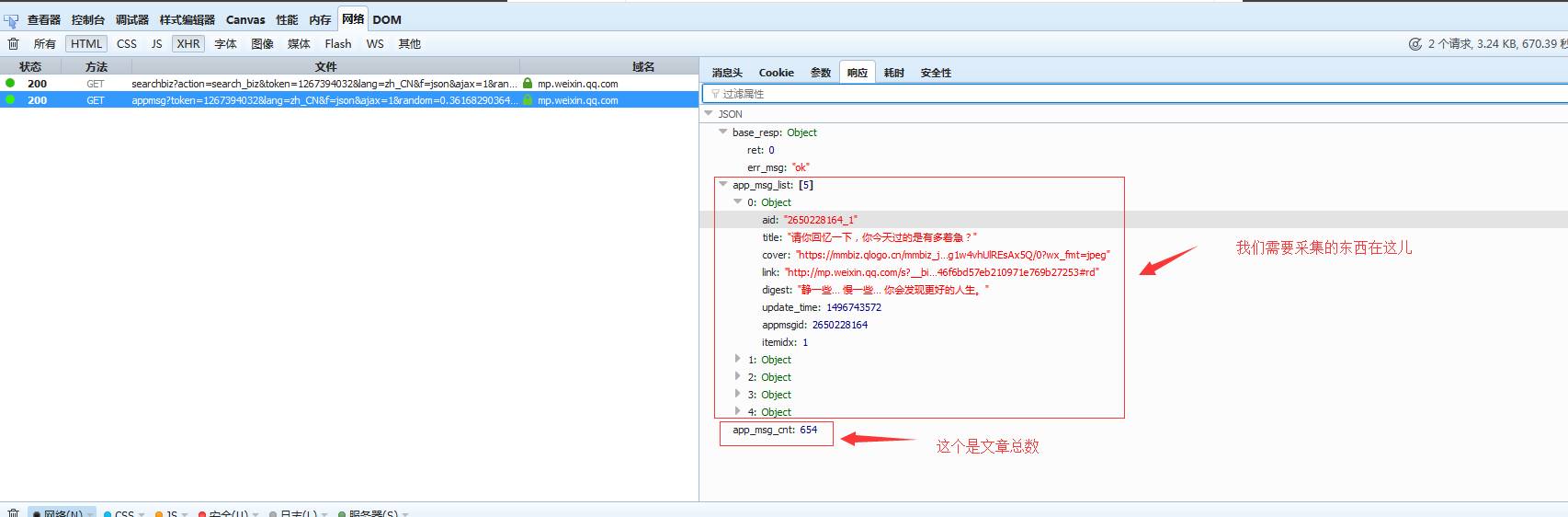

5. 单击我们搜索的官方帐户后,发现了另一个请求:

请求参数如下:

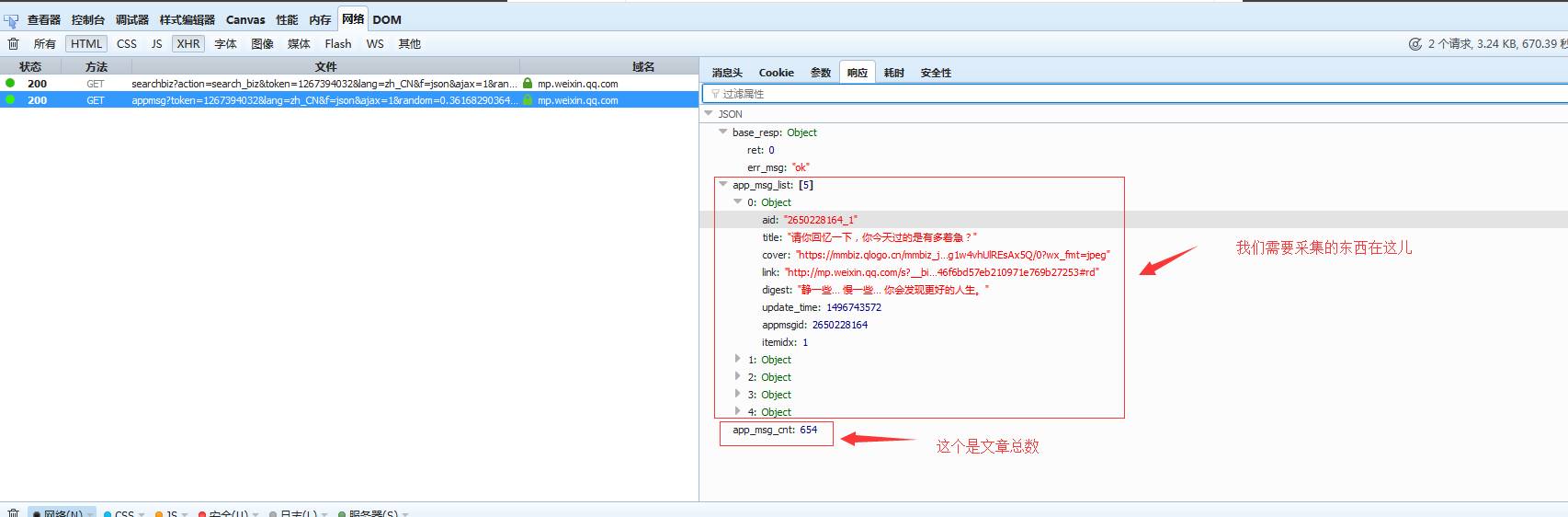

返回结果如下:

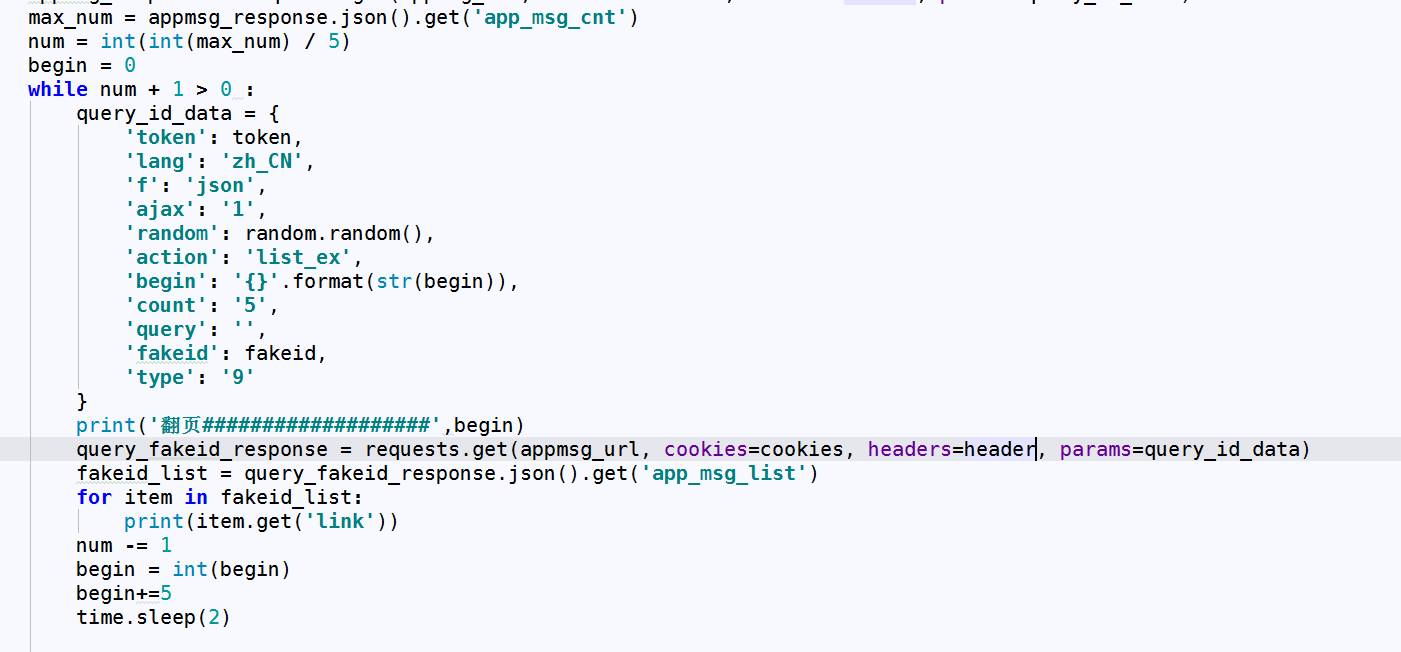

代码如下:

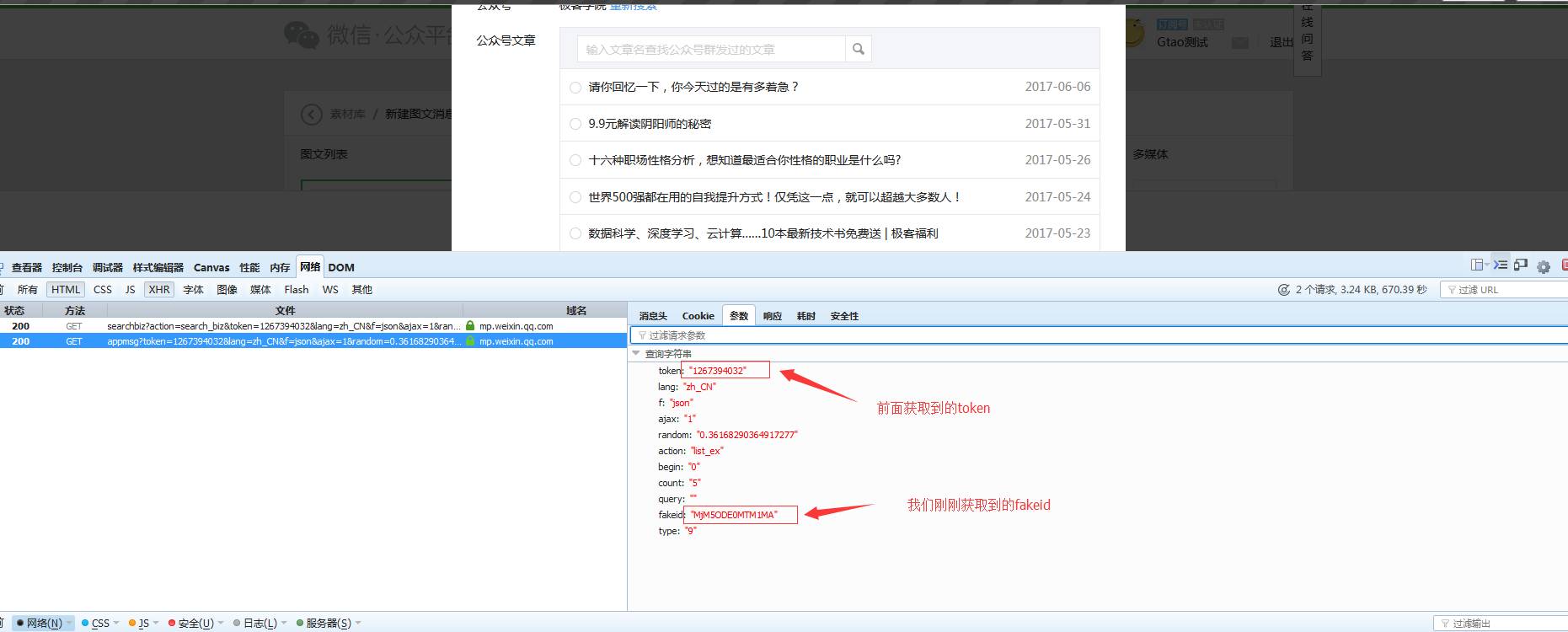

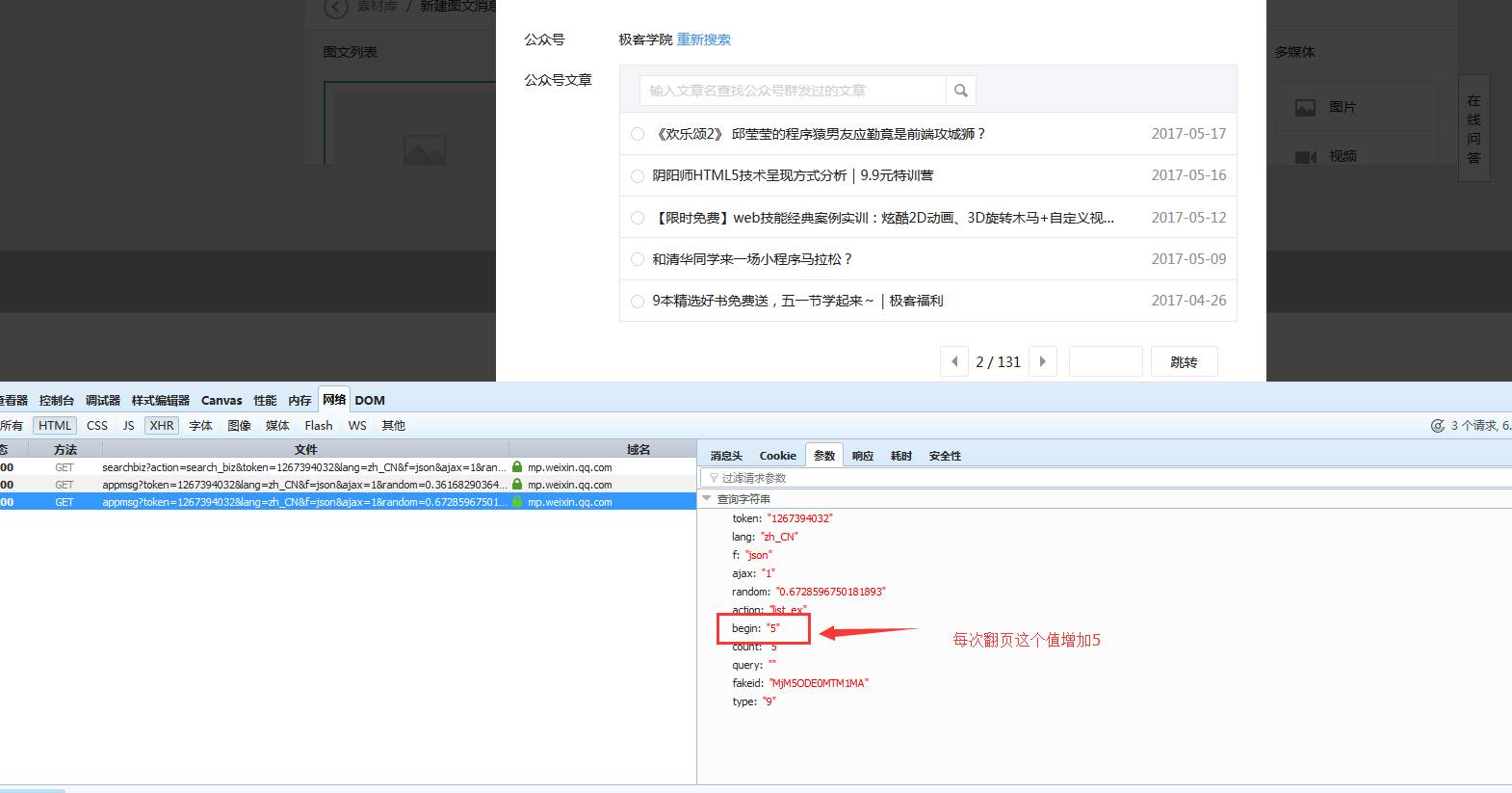

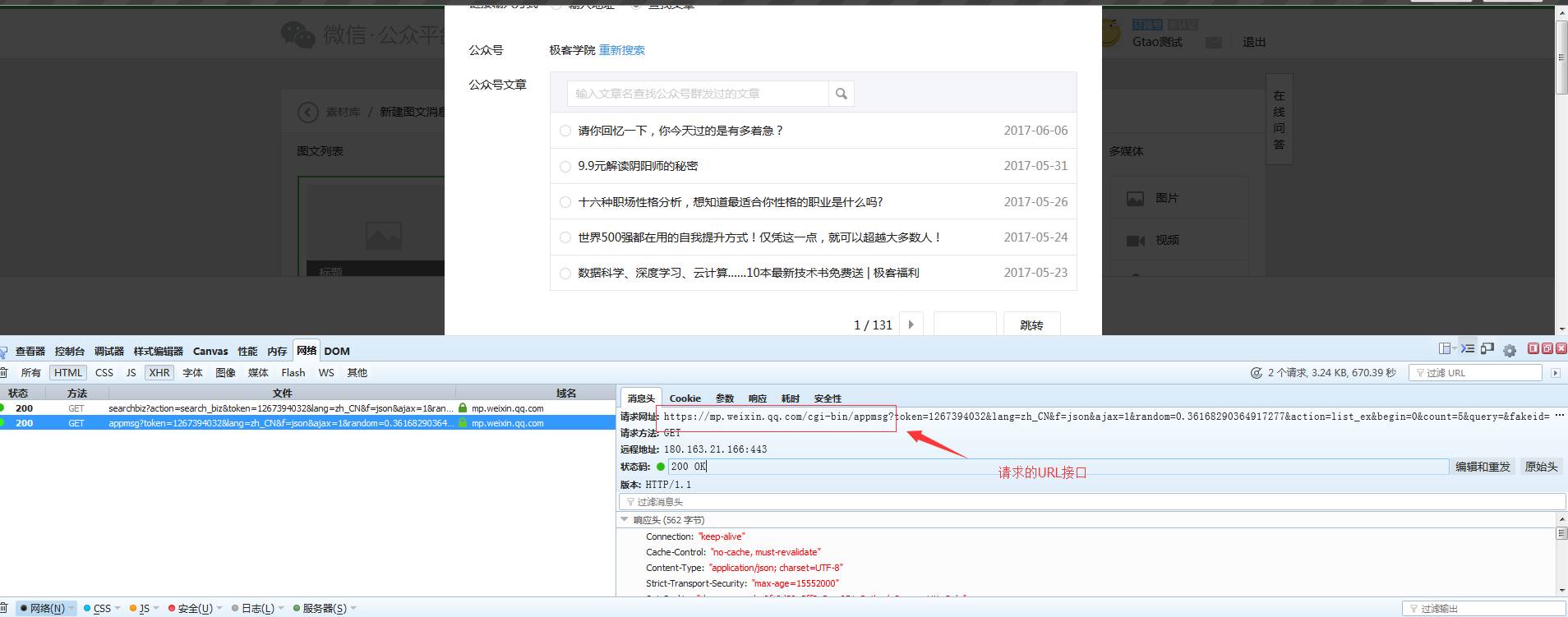

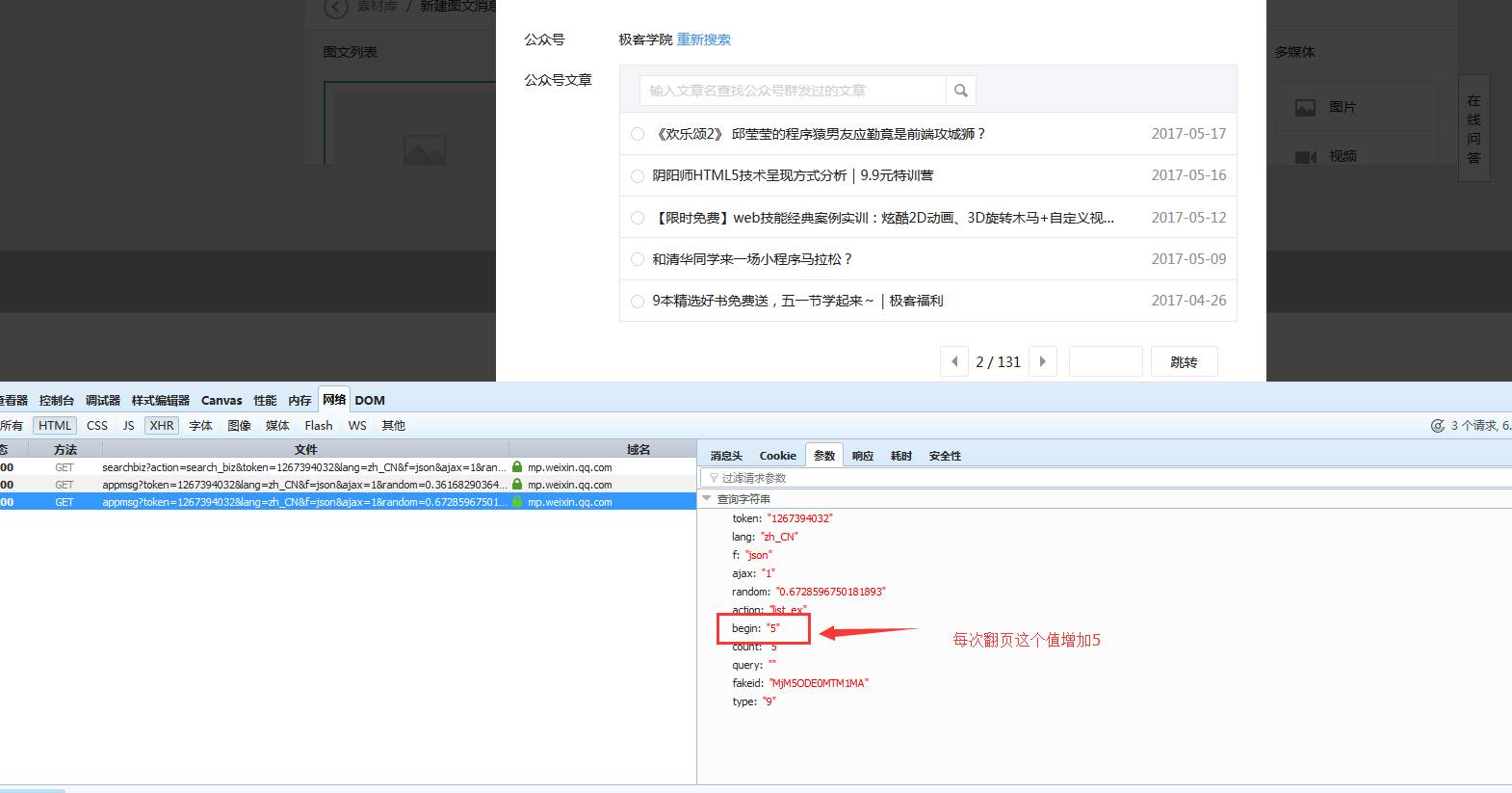

好吧···最后一步,要获取所有文章,您需要处理翻页. 翻页请求如下:

我可能看了一眼. 极客学院的每一页至少有5条信息,即文章总数/ 5 /有多少页. 但是有小数,我们将其四舍五入,然后加1以得到总页数.

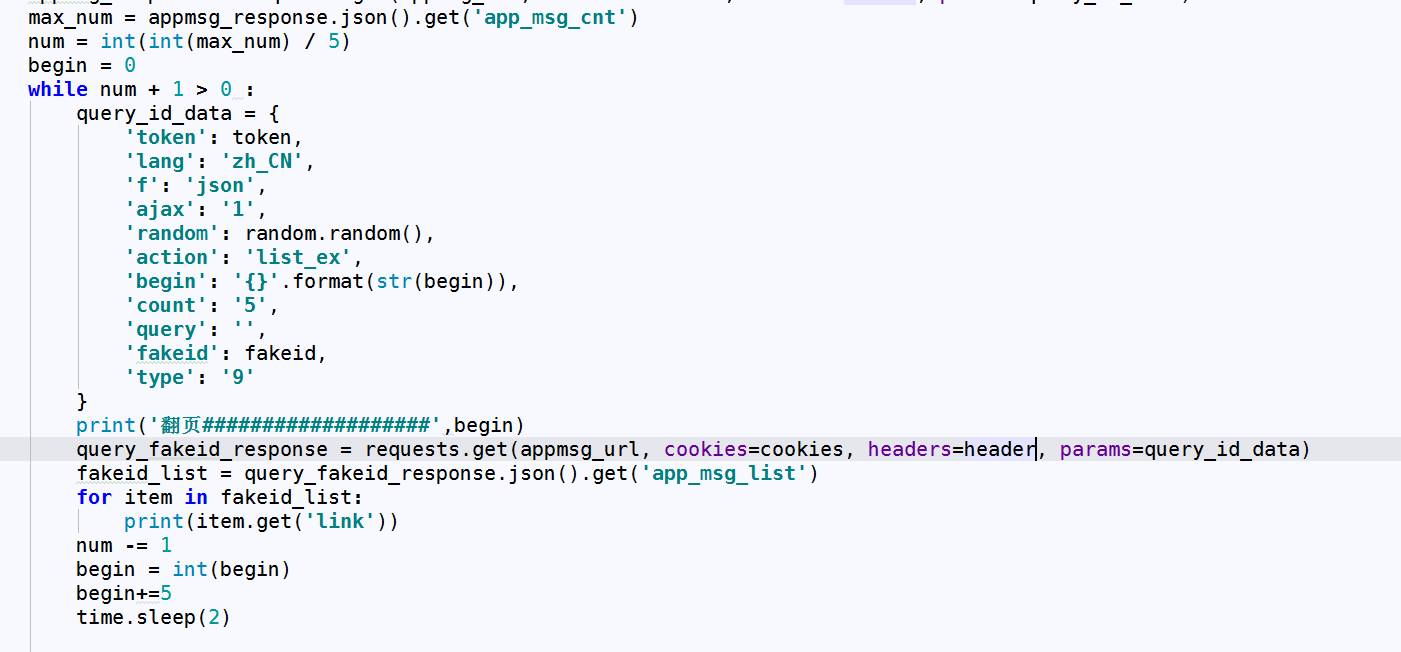

代码如下:

item.get(‘link’)是我们需要的官方帐户文章链接!继续请求该URL以提取其中的内容!

结束. 查看全部

伙计们,您一定遭受了采集微信公众号的困扰!特别! ! ! ! ! !公开帐户历史记录信息! ! !除了通过中间代理采集APP外,实际上没有任何技巧可以获取数据!

直到···········

前一段时间,微信在当晚正式发布了一篇文章:

妈妈!这不是始终需要的采集接口!嘿,上帝也帮助我!来...让我们谈谈一般方法.

1. 首先,您需要一个订阅帐户!我不知道官方帐户和企业帐户是否可行. 因为我没有...

2. 接下来,您需要登录!

我没有仔细查看微信官方帐户登录.

暂且不说,我使用硒的方法来驱动浏览器获取cookie以达到登录效果.

3. 使用请求携带cookie,登录以获取URL的令牌(这很重要,您需要在每个请求中都带上它),如下所示:

4. 使用获取的令牌和官方账号的微信ID(即数字+字符)来获取官方账号的伪造品(可以了解官方账号的身份)

当我们搜索官方帐户时,浏览器使用GET方法向带参数的红色框中的URL发起了请求. 请求参数如下:

请求如下:

代码如下:

好的,让我们继续:

5. 单击我们搜索的官方帐户后,发现了另一个请求:

请求参数如下:

返回结果如下:

代码如下:

好吧···最后一步,要获取所有文章,您需要处理翻页. 翻页请求如下:

我可能看了一眼. 极客学院的每一页至少有5条信息,即文章总数/ 5 /有多少页. 但是有小数,我们将其四舍五入,然后加1以得到总页数.

代码如下: