文章采集链接

分享文章:微信公众号文章采集及临时链接转永久链接

采集交流 • 优采云 发表了文章 • 0 个评论 • 543 次浏览 • 2020-12-07 13:10

2017年10月12日23:03:37微信公众号文章采集和临时链接到永久链接

一、让我们首先讨论整体解决方案

1、使用搜狗执行官方帐户文章的采集,以这种方式获得的文章URL是带有时间戳的临时链接。

2、通过Android仿真器+ Anyproxy代理捕获,在打开临时链接时分析微信客户端及其服务器请求的协议的内容,并获得永久链接。

3、通过按钮向导模拟或Python脚本在微信帐户上发送临时链接内容。只有在Android模拟器上的微信帐户上发送了内容之后,Anyproxy代理才能获取相关的软件包内容。

二、让我们讨论具体的解决方案,主要是第二点

1、使用搜狗执行官方帐户文章的采集,以这种方式获得的文章URL是带有时间戳的临时链接。将其用作数据采集时,经常会出现“请输入验证码”。我尝试使用IP代理池,但没有找到可以避免或解决此问题的IP代理服务器。我处理此问题的方法是使用动态IP VPS服务。我不会详细介绍具体步骤,因为这不是本文章的重点。

2、通过Android仿真器+ Anyproxy代理捕获,在打开临时链接时分析微信客户端及其服务器请求的协议的内容,并获得永久链接。我使用win10系统。

1)一个微信客户端:下载一个Android模拟器并在该模拟器上安装一个WeChat应用。

2)一个微信个人帐户:对于采集的内容,不仅需要一个微信客户端,而且还需要一个专用于发送临时链接的微信个人帐户。

3)本地代理服务器系统:当前使用的方法是将临时链接和永久链接发送到我们自己的服务器,以通过Anyproxy代理服务器进行替换。具体安装方法将在后面详细说明。

当前,我使用Anyproxy。该软件的功能是您可以获取https链接的内容。 2016年初,微信公众号和微信文章开始使用https链接。而且Anyproxy可以通过修改规则将请求发送到服务器。下面开始介绍安装和配置过程。

1、安装NodeJS

2、在命令行或终端上运行npm install -g anyproxy

3、生成RootCA,https需要此证书:运行命令anyproxy --root

4、启动anyproxy运行命令:win + R打开并运行,输入anyproxy -i;参数-i表示解析HTTPS;

5、安装证书,在Android仿真器中安装证书:启动anyproxy,打开浏览器:8002 / fetchCrtFile,您可以获取rootCA.crt文件

6、设置代理:Android仿真器的代理服务器地址是wifi链接的网关。将dhcp设置为static后,您可以看到网关地址。阅读后不要忘记将其设置为自动。代理服务器的默认端口为8001。

检查是否成功的方法:在模拟器上打开微信,单击任何文章,然后您可以在终端中看到响应代码滚动。如果未出现,请检查手机的代理设置是否正确。我的以下屏幕截图是打开浏览器地址:8002,以查看anyproxy的Web界面。

我在微信应用程序上打开了文章的临时链接。通过协议分析,我们可以知道永久链接被重定向到302的位置。

4)修改Anyproxy文件rule_default.js以在捕获的数据包中获取协议内容。

rule_default.js文件位于* \ node_modules \ anyproxy \ lib \ rule_default.js中,找到replaceServerResDataAsync:function(req,res,serverResData,callback)函数,修改该函数的内容,并劫持所需的内容。因为我只需要抢回以302返回的代码的内容,所以我只在statusCode == 302时回叫。

找到replaceResponseHeader:function(req,res,header)函数并修改该函数的内容。获取永久链接,并调用我在服务器上编写的http接口。我的界面只有两个参数:临时链接和永久链接。永久链接是基于临时链接添加的。

3、使用按钮向导模拟在微信应用程序上单击临时链接,或者您可以通过python脚本模拟它。我正在写这篇文章,完成后我将对其进行更新。 查看全部

微信官方帐户文章采集和指向永久链接的临时链接

2017年10月12日23:03:37微信公众号文章采集和临时链接到永久链接

一、让我们首先讨论整体解决方案

1、使用搜狗执行官方帐户文章的采集,以这种方式获得的文章URL是带有时间戳的临时链接。

2、通过Android仿真器+ Anyproxy代理捕获,在打开临时链接时分析微信客户端及其服务器请求的协议的内容,并获得永久链接。

3、通过按钮向导模拟或Python脚本在微信帐户上发送临时链接内容。只有在Android模拟器上的微信帐户上发送了内容之后,Anyproxy代理才能获取相关的软件包内容。

二、让我们讨论具体的解决方案,主要是第二点

1、使用搜狗执行官方帐户文章的采集,以这种方式获得的文章URL是带有时间戳的临时链接。将其用作数据采集时,经常会出现“请输入验证码”。我尝试使用IP代理池,但没有找到可以避免或解决此问题的IP代理服务器。我处理此问题的方法是使用动态IP VPS服务。我不会详细介绍具体步骤,因为这不是本文章的重点。

2、通过Android仿真器+ Anyproxy代理捕获,在打开临时链接时分析微信客户端及其服务器请求的协议的内容,并获得永久链接。我使用win10系统。

1)一个微信客户端:下载一个Android模拟器并在该模拟器上安装一个WeChat应用。

2)一个微信个人帐户:对于采集的内容,不仅需要一个微信客户端,而且还需要一个专用于发送临时链接的微信个人帐户。

3)本地代理服务器系统:当前使用的方法是将临时链接和永久链接发送到我们自己的服务器,以通过Anyproxy代理服务器进行替换。具体安装方法将在后面详细说明。

当前,我使用Anyproxy。该软件的功能是您可以获取https链接的内容。 2016年初,微信公众号和微信文章开始使用https链接。而且Anyproxy可以通过修改规则将请求发送到服务器。下面开始介绍安装和配置过程。

1、安装NodeJS

2、在命令行或终端上运行npm install -g anyproxy

3、生成RootCA,https需要此证书:运行命令anyproxy --root

4、启动anyproxy运行命令:win + R打开并运行,输入anyproxy -i;参数-i表示解析HTTPS;

5、安装证书,在Android仿真器中安装证书:启动anyproxy,打开浏览器:8002 / fetchCrtFile,您可以获取rootCA.crt文件

6、设置代理:Android仿真器的代理服务器地址是wifi链接的网关。将dhcp设置为static后,您可以看到网关地址。阅读后不要忘记将其设置为自动。代理服务器的默认端口为8001。

检查是否成功的方法:在模拟器上打开微信,单击任何文章,然后您可以在终端中看到响应代码滚动。如果未出现,请检查手机的代理设置是否正确。我的以下屏幕截图是打开浏览器地址:8002,以查看anyproxy的Web界面。

我在微信应用程序上打开了文章的临时链接。通过协议分析,我们可以知道永久链接被重定向到302的位置。

4)修改Anyproxy文件rule_default.js以在捕获的数据包中获取协议内容。

rule_default.js文件位于* \ node_modules \ anyproxy \ lib \ rule_default.js中,找到replaceServerResDataAsync:function(req,res,serverResData,callback)函数,修改该函数的内容,并劫持所需的内容。因为我只需要抢回以302返回的代码的内容,所以我只在statusCode == 302时回叫。

找到replaceResponseHeader:function(req,res,header)函数并修改该函数的内容。获取永久链接,并调用我在服务器上编写的http接口。我的界面只有两个参数:临时链接和永久链接。永久链接是基于临时链接添加的。

3、使用按钮向导模拟在微信应用程序上单击临时链接,或者您可以通过python脚本模拟它。我正在写这篇文章,完成后我将对其进行更新。

免费:微信公众号数据采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 368 次浏览 • 2020-10-16 08:09

内容

最近统计感兴趣的公共帐户的阅读数据。本文文章将记录实施过程。本文仅用于学习和交流,请勿将其用于其他目的。

一、采集官方帐户文章 URL

该程序的主要考虑因素是在窗口下运行。在运行之前,请确保您具有python和相关python插件的基本运行环境。

1.操作环境1. Webdriver

确保窗口环境中有Google浏览器。如果您使用的Google浏览器版本不支持程序中提供的网络驱动程序,则有以下解决方案:

首先,在您的计算机上下载与Google浏览器版本相对应的网络驱动程序

第二个是安装文件中提供的gongle浏览器

第三种方法是自行查找其他浏览器的相应网络驱动程序(此处不推荐这样做,除非您可以解决遇到的问题)

2.python操作环境

python版本> =3.6

3.cx-oracle

版本5.3此版本对应于服务器上的oracle数据库版本11g,无法连接其他版本

pip install oracle == 5.3

4.lxml

execl文件操作所需的插件

pip install lxml

5.注册一个微信官方帐户

也使用现有的

2.采集 文章连接1.配置config.txt

可以使用多个正式帐户配置此文件。该程序将下载已配置的官方帐户的文章 url 采集。请注意,格式为:

每个正式帐户只有一行

正式帐户名称开始时间结束时间

需要采集的正式帐户名,并且采集的开始时间和结束时间用空格分隔。该程序只会在开始时间和结束时间之内保存文章的数据。

2.启动程序

单击JZTravel_Artical_Url.bat,在微信上扫描,登录到微信公众号,成功登录后,您将进入微信公众号页面,请勿关闭此页面,因为程序会自动退出该页面,并且程序将采集 文章 url。

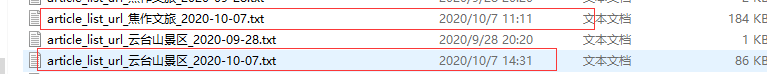

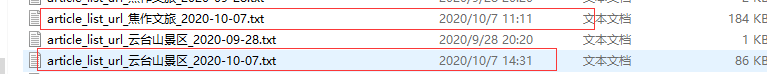

程序运行后,将在data文件夹中生成相应的文件,其中收录需要采集的微信官方帐户文章的网址。

注意:在登录过程中,可能会出现以下错误,请放心,这可能是当前的网络问题,导致页面上的数据无法完全加载,请重试几次。

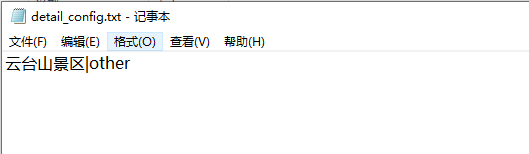

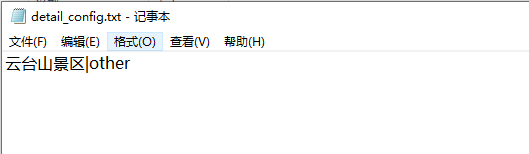

二、采集 文章详细信息1.配置detail_config.txt

采集官方帐户详细信息配置文件

注意:由于使用cookie,该文件只能配置一个正式帐户信息,并且要求采集的正式帐户必须与cookie中的连接相对应,格式为

官方帐户名|数据存储方法

需要采集的正式帐户。存储方法用“ |”分隔。共有三种软件包存储方法,xls(另存为execl,oracle)保存到oracle数据库,其他(同时保存到execl文件和Oracle数据库)。根据实际需要选择。

2.启动程序

单击JZTravel_Artical_Detail.bat,程序将自动采集 文章详细数据。

注意:

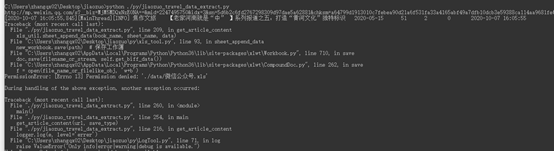

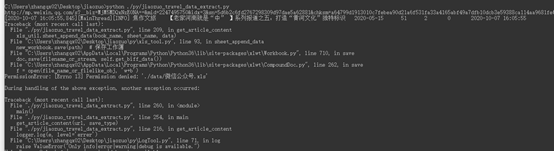

错误1:程序中发生以下错误时,它不会影响采集程序,也不会影响采集的结果

错误2:如果程序中发生以下错误,则是由于Cookie失败引起的。您需要再次导入cookie数据。不用担心,已重复采集的文章数据将不会重复采集。

错误三:程序中出现以下错误时,将打开由采集器程序编写的Excel文件,并且需要关闭该文件以重新启动程序,即,在采集器期间无法打开execl文件。 采集。

三、数据

考虑到正在运行的爬网程序的实际网络环境,此处使用多个数据备份。包括数据本地文件备份和数据库备份。

1.数据库

2.Execl

根据采集日期分别保存。

本文仅用于学习和交流,请勿将其用于其他目的。技术支持(扣除):3165845957 查看全部

微信公众号数据采集

内容

最近统计感兴趣的公共帐户的阅读数据。本文文章将记录实施过程。本文仅用于学习和交流,请勿将其用于其他目的。

一、采集官方帐户文章 URL

该程序的主要考虑因素是在窗口下运行。在运行之前,请确保您具有python和相关python插件的基本运行环境。

1.操作环境1. Webdriver

确保窗口环境中有Google浏览器。如果您使用的Google浏览器版本不支持程序中提供的网络驱动程序,则有以下解决方案:

首先,在您的计算机上下载与Google浏览器版本相对应的网络驱动程序

第二个是安装文件中提供的gongle浏览器

第三种方法是自行查找其他浏览器的相应网络驱动程序(此处不推荐这样做,除非您可以解决遇到的问题)

2.python操作环境

python版本> =3.6

3.cx-oracle

版本5.3此版本对应于服务器上的oracle数据库版本11g,无法连接其他版本

pip install oracle == 5.3

4.lxml

execl文件操作所需的插件

pip install lxml

5.注册一个微信官方帐户

也使用现有的

2.采集 文章连接1.配置config.txt

可以使用多个正式帐户配置此文件。该程序将下载已配置的官方帐户的文章 url 采集。请注意,格式为:

每个正式帐户只有一行

正式帐户名称开始时间结束时间

需要采集的正式帐户名,并且采集的开始时间和结束时间用空格分隔。该程序只会在开始时间和结束时间之内保存文章的数据。

2.启动程序

单击JZTravel_Artical_Url.bat,在微信上扫描,登录到微信公众号,成功登录后,您将进入微信公众号页面,请勿关闭此页面,因为程序会自动退出该页面,并且程序将采集 文章 url。

程序运行后,将在data文件夹中生成相应的文件,其中收录需要采集的微信官方帐户文章的网址。

注意:在登录过程中,可能会出现以下错误,请放心,这可能是当前的网络问题,导致页面上的数据无法完全加载,请重试几次。

二、采集 文章详细信息1.配置detail_config.txt

采集官方帐户详细信息配置文件

注意:由于使用cookie,该文件只能配置一个正式帐户信息,并且要求采集的正式帐户必须与cookie中的连接相对应,格式为

官方帐户名|数据存储方法

需要采集的正式帐户。存储方法用“ |”分隔。共有三种软件包存储方法,xls(另存为execl,oracle)保存到oracle数据库,其他(同时保存到execl文件和Oracle数据库)。根据实际需要选择。

2.启动程序

单击JZTravel_Artical_Detail.bat,程序将自动采集 文章详细数据。

注意:

错误1:程序中发生以下错误时,它不会影响采集程序,也不会影响采集的结果

错误2:如果程序中发生以下错误,则是由于Cookie失败引起的。您需要再次导入cookie数据。不用担心,已重复采集的文章数据将不会重复采集。

错误三:程序中出现以下错误时,将打开由采集器程序编写的Excel文件,并且需要关闭该文件以重新启动程序,即,在采集器期间无法打开execl文件。 采集。

三、数据

考虑到正在运行的爬网程序的实际网络环境,此处使用多个数据备份。包括数据本地文件备份和数据库备份。

1.数据库

2.Execl

根据采集日期分别保存。

本文仅用于学习和交流,请勿将其用于其他目的。技术支持(扣除):3165845957

推荐文章:如何给网站添加内部链接

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2020-09-07 00:12

很长一段时间,所有SEO初学者都不知道如何向网站内容添加内部链接(内部链接)。内部链接在SEO流程中起着至关重要的作用。通过内部链接,不仅可以增加网站的权重,而且可以改善网站相关关键词的排名;内部链接传递网站的权重,它还连接以前的文章以增加阅读范围,增强用户体验,并提高百度收录的效率。

许多朋友问我如何在网站和博客中添加内部链接。关于这个问题,我只能羞于告诉您,我使用最基本的方法来手动添加内部链接。在编写文章时,在编写关键词时,找出这些文章并通过某些方法过滤掉最佳的文章,以免影响用户体验。在这种情况下,添加它。

许多朋友问我是否有构建网站的方法,或者是一种在编写相关关键词时可以直接插入内部链接的插件。关于这个问题,我只能说没有程序,没有人会比你更了解你的网站和内容。如果网站的内容完全是您自己的原创,那么任何文章都将存储在您的大脑中。只要编写相关问题,您就会自然地反映出这一点关键词,加入内部链接是很自然的。插件生成的内部链接可能会影响用户体验,整篇文章文章许多内部链接不仅会影响用户体验,当您不使用搜索引擎时,很容易认为您的网站正在执行SEO不太了解搜索引擎算法。作弊。以下是添加网站内部链接的说明:

首先,把握时间添加内部链接。如上所述,原创的文章或多或少会给人留下一些印象。当文章中出现某个关键词时,自然会添加内部链接,这非常好。 ,从整个文章文章布局关键词和内部链接中,我对用户体验有了最适当的掌握。这也是一个非常好的帮助,它可以促进尚未被搜索引擎抓取的文章继续进行收录。

第二,添加内部链接可以提高某些关键词的排名。例如,我想将SEO教程关键词排在最前面,因此当我参考文章中的SEO教程时,我将添加内部链接,这对于提高列的排名非常重要。而且,如果我想在SEO优化中排名较高关键词,那么在添加内部链接时,我应该将该链接添加到此列中。

同样,添加内部链接将帮助长尾关键词排名。我认为许多SEO专家都知道这种方法,因此您在阅读本文时可以跳过此段。在编写文章时,当出现类似的单词时,我们可以将曾经出现的文章链接添加到此长尾巴关键词中。许多朋友会再次问,如果文章中的这个词有很多文章,该怎么办?目前,我们可以通过百度或Google等搜索引擎搜索长尾关键词,并将此页面的链接添加到内部链接中以获得最高排名,这将有助于长尾关键词排名不断提高。经过长期积累,将会有很多长尾关键词排名。

最后,有计划添加旨在帮助内容收录的内部链接。很长一段时间,我进行了测试。在文章的一部分中,未添加内部链接,并且收录的一小部分尚未添加; 文章的另一部分已被写入,但尚未添加。 收录的文章用作内部链接。此时,收录中的文章还没有收录。因此,在不影响用户体验的前提下,我们计划有针对性地添加网站内部链接,这对收录非常有帮助。例如,我曾经写过一篇标题为文章的搜索引擎提交入口文章。还没有收录,但是在提到文章几篇文章并添加了内部链接之后,文章的这篇文章也很成功收录,排名也不断提高。

如今,在百度推出Luluo算法的一般环境中,许多朋友已经关注了高质量外部链接的增加,并且还在不断改善网站内容的构建,但是我想这里说的是,内容构建也是没有内部链接的构建,良好的网站将得到良好的内部链接结构的支持。这样不仅可以帮助网站增加流量并增强用户体验,还可以防止文章 采集。

在这里写,我想您绝对可以解决如何向网站添加内部链接的问题。至少部分可以解决。我希望这种方法可以增进每个人对SEO的理解,并提高内容质量。整个Internet应用程序环境。 查看全部

如何将内部链接添加到网站

很长一段时间,所有SEO初学者都不知道如何向网站内容添加内部链接(内部链接)。内部链接在SEO流程中起着至关重要的作用。通过内部链接,不仅可以增加网站的权重,而且可以改善网站相关关键词的排名;内部链接传递网站的权重,它还连接以前的文章以增加阅读范围,增强用户体验,并提高百度收录的效率。

许多朋友问我如何在网站和博客中添加内部链接。关于这个问题,我只能羞于告诉您,我使用最基本的方法来手动添加内部链接。在编写文章时,在编写关键词时,找出这些文章并通过某些方法过滤掉最佳的文章,以免影响用户体验。在这种情况下,添加它。

许多朋友问我是否有构建网站的方法,或者是一种在编写相关关键词时可以直接插入内部链接的插件。关于这个问题,我只能说没有程序,没有人会比你更了解你的网站和内容。如果网站的内容完全是您自己的原创,那么任何文章都将存储在您的大脑中。只要编写相关问题,您就会自然地反映出这一点关键词,加入内部链接是很自然的。插件生成的内部链接可能会影响用户体验,整篇文章文章许多内部链接不仅会影响用户体验,当您不使用搜索引擎时,很容易认为您的网站正在执行SEO不太了解搜索引擎算法。作弊。以下是添加网站内部链接的说明:

首先,把握时间添加内部链接。如上所述,原创的文章或多或少会给人留下一些印象。当文章中出现某个关键词时,自然会添加内部链接,这非常好。 ,从整个文章文章布局关键词和内部链接中,我对用户体验有了最适当的掌握。这也是一个非常好的帮助,它可以促进尚未被搜索引擎抓取的文章继续进行收录。

第二,添加内部链接可以提高某些关键词的排名。例如,我想将SEO教程关键词排在最前面,因此当我参考文章中的SEO教程时,我将添加内部链接,这对于提高列的排名非常重要。而且,如果我想在SEO优化中排名较高关键词,那么在添加内部链接时,我应该将该链接添加到此列中。

同样,添加内部链接将帮助长尾关键词排名。我认为许多SEO专家都知道这种方法,因此您在阅读本文时可以跳过此段。在编写文章时,当出现类似的单词时,我们可以将曾经出现的文章链接添加到此长尾巴关键词中。许多朋友会再次问,如果文章中的这个词有很多文章,该怎么办?目前,我们可以通过百度或Google等搜索引擎搜索长尾关键词,并将此页面的链接添加到内部链接中以获得最高排名,这将有助于长尾关键词排名不断提高。经过长期积累,将会有很多长尾关键词排名。

最后,有计划添加旨在帮助内容收录的内部链接。很长一段时间,我进行了测试。在文章的一部分中,未添加内部链接,并且收录的一小部分尚未添加; 文章的另一部分已被写入,但尚未添加。 收录的文章用作内部链接。此时,收录中的文章还没有收录。因此,在不影响用户体验的前提下,我们计划有针对性地添加网站内部链接,这对收录非常有帮助。例如,我曾经写过一篇标题为文章的搜索引擎提交入口文章。还没有收录,但是在提到文章几篇文章并添加了内部链接之后,文章的这篇文章也很成功收录,排名也不断提高。

如今,在百度推出Luluo算法的一般环境中,许多朋友已经关注了高质量外部链接的增加,并且还在不断改善网站内容的构建,但是我想这里说的是,内容构建也是没有内部链接的构建,良好的网站将得到良好的内部链接结构的支持。这样不仅可以帮助网站增加流量并增强用户体验,还可以防止文章 采集。

在这里写,我想您绝对可以解决如何向网站添加内部链接的问题。至少部分可以解决。我希望这种方法可以增进每个人对SEO的理解,并提高内容质量。整个Internet应用程序环境。

官方数据:起点中文网越来越火爆了,我利用Python直接把整站数据采集完毕

采集交流 • 优采云 发表了文章 • 0 个评论 • 372 次浏览 • 2020-09-05 04:05

注意:PEP 20是著名的Python Zen。

警告:非专业使用其他HTTP库可能导致危险的副作用,包括:安全缺陷,冗余代码综合症,重塑车轮综合症,文件咬伤综合症,沮丧,头痛甚至死亡。

2.功能

据说请求功能强大,那么让我们看一下请求的功能:

请求完全满足当今网络的需求。请求支持Python 2. 6- 2. 7和3. 3- 3. 7,并且可以在PyPy下完美运行

三、安装请求

pip安装请求

如果是pip3,则使用

pip3安装请求

如果您使用水蟒,则可以

conda安装请求

如果您不想使用命令行,则可以在pycharm中下载类似的库

四、采集器进程

下图是Brother Pig先前工作总结的项目开发过程。它很详细。确实有必要如此详细地开发大型项目。否则,项目将失败或修改需求。程序员有可能牺牲自己的生命。 。

靠近主题,向所有人显示项目的开发过程将导致爬网数据的过程:

确定需要爬网的Web浏览器。检查数据源(静态网页或动态加载)以查找加载数据URL(例如分页)代码模拟请求以爬网数据的参数规律

起点中文网成立于2002年5月。它是中国最大的文学阅读和写作平台之一。它是领先的原创文学门户网站,属于China-Reading集团下最大的综合数字内容平台。

总体思路分为三个步骤:

1.分析网页结构,使用xpath表达式对所有文章名称和链接进行爬网,然后按文章名称生成文件夹。

import requests

from urllib import request

from lxml import etree

import os

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.100 Safari/537.36'}

class Spider(object):

def start_request(self):

url = 'https://www.qidian.com/all'

req = request.Request(url,headers=header)

html= request.urlopen(req).read().decode('utf-8')

html=etree.HTML(html)

bigtit_list=html.xpath('//div[@class="book-mid-info"]/h4/a/text()') ##爬取所有的文章名字

bigsrc_list = html.xpath('//div[@class="book-mid-info"]/h4/a/@href')

print(bigtit_list)

print(bigsrc_list)

for bigtit,bigsrc in zip(bigtit_list,bigsrc_list):

if os.path.exists(bigtit)==False:

os.mkdir(bigtit)

self.file_data(bigsrc,bigtit)

2.使用文章链接抓取每个章节的名称和链接

def file_data(self,bigsrc,bigtit): #详情页

url="http:"+bigsrc

req = request.Request(url, headers=header)

html = request.urlopen(req).read().decode('utf-8')

html = etree.HTML(html)

print(html)

Lit_tit_list = html.xpath('//ul[@class="cf"]/li/a/text()') #爬取每个章节名字

Lit_href_list = html.xpath('//ul[@class="cf"]/li/a/@href') #每个章节链接

for tit,src in zip(Lit_tit_list,Lit_href_list):

self.finally_file(tit,src,bigtit)

3.使用每个章节的链接来生成带有章节名称的txt文件,并将其保存到每个文章文件夹中。

def finally_file(self,tit,src,bigtit):

url = "http:" + src

req = request.Request(url, headers=header)

html = request.urlopen(req).read().decode('utf-8')

html = etree.HTML(html)

text_list = html.xpath('//div[@class="read-content j_readContent"]/p/text()')

text = "\n".join(text_list)

file_name = bigtit + "\\" + tit + ".txt"

print("正在抓取文章:" + file_name)

with open(file_name, 'a', encoding="utf-8") as f:

f.write(text)

spider=Spider()

spider.start_request()

成功!

生成的文件夹如下所示: 查看全部

起点中文网站越来越受欢迎,我使用Python直接完成整个网站数据采集

注意:PEP 20是著名的Python Zen。

警告:非专业使用其他HTTP库可能导致危险的副作用,包括:安全缺陷,冗余代码综合症,重塑车轮综合症,文件咬伤综合症,沮丧,头痛甚至死亡。

2.功能

据说请求功能强大,那么让我们看一下请求的功能:

请求完全满足当今网络的需求。请求支持Python 2. 6- 2. 7和3. 3- 3. 7,并且可以在PyPy下完美运行

三、安装请求

pip安装请求

如果是pip3,则使用

pip3安装请求

如果您使用水蟒,则可以

conda安装请求

如果您不想使用命令行,则可以在pycharm中下载类似的库

四、采集器进程

下图是Brother Pig先前工作总结的项目开发过程。它很详细。确实有必要如此详细地开发大型项目。否则,项目将失败或修改需求。程序员有可能牺牲自己的生命。 。

靠近主题,向所有人显示项目的开发过程将导致爬网数据的过程:

确定需要爬网的Web浏览器。检查数据源(静态网页或动态加载)以查找加载数据URL(例如分页)代码模拟请求以爬网数据的参数规律

起点中文网成立于2002年5月。它是中国最大的文学阅读和写作平台之一。它是领先的原创文学门户网站,属于China-Reading集团下最大的综合数字内容平台。

总体思路分为三个步骤:

1.分析网页结构,使用xpath表达式对所有文章名称和链接进行爬网,然后按文章名称生成文件夹。

import requests

from urllib import request

from lxml import etree

import os

header = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.100 Safari/537.36'}

class Spider(object):

def start_request(self):

url = 'https://www.qidian.com/all'

req = request.Request(url,headers=header)

html= request.urlopen(req).read().decode('utf-8')

html=etree.HTML(html)

bigtit_list=html.xpath('//div[@class="book-mid-info"]/h4/a/text()') ##爬取所有的文章名字

bigsrc_list = html.xpath('//div[@class="book-mid-info"]/h4/a/@href')

print(bigtit_list)

print(bigsrc_list)

for bigtit,bigsrc in zip(bigtit_list,bigsrc_list):

if os.path.exists(bigtit)==False:

os.mkdir(bigtit)

self.file_data(bigsrc,bigtit)

2.使用文章链接抓取每个章节的名称和链接

def file_data(self,bigsrc,bigtit): #详情页

url="http:"+bigsrc

req = request.Request(url, headers=header)

html = request.urlopen(req).read().decode('utf-8')

html = etree.HTML(html)

print(html)

Lit_tit_list = html.xpath('//ul[@class="cf"]/li/a/text()') #爬取每个章节名字

Lit_href_list = html.xpath('//ul[@class="cf"]/li/a/@href') #每个章节链接

for tit,src in zip(Lit_tit_list,Lit_href_list):

self.finally_file(tit,src,bigtit)

3.使用每个章节的链接来生成带有章节名称的txt文件,并将其保存到每个文章文件夹中。

def finally_file(self,tit,src,bigtit):

url = "http:" + src

req = request.Request(url, headers=header)

html = request.urlopen(req).read().decode('utf-8')

html = etree.HTML(html)

text_list = html.xpath('//div[@class="read-content j_readContent"]/p/text()')

text = "\n".join(text_list)

file_name = bigtit + "\\" + tit + ".txt"

print("正在抓取文章:" + file_name)

with open(file_name, 'a', encoding="utf-8") as f:

f.write(text)

spider=Spider()

spider.start_request()

成功!

生成的文件夹如下所示:

教程:揭秘百度贴吧留链接的三种方式

采集交流 • 优采云 发表了文章 • 0 个评论 • 182 次浏览 • 2020-09-03 22:34

百度贴吧的流量很大,但是基本上不可能通过常规渠道与网站建立链接。接下来,我将以我的亲身经历向您介绍。百度贴吧离开链接的3种方法是干货,哈哈,不只是百度贴吧。在百度之后,也有不同的方法可以做到这一点。好吧,我们不要再胡说八道了,转到话题:

第一种方法是使用百度的内在产品

百度的内部产品不过是百度空间和百度搜索。这个方法很简单。百度空间是百度的博客,它的权重很高。进行外部链接也很好。它类似于新浪和网易。自己写文章,我不会再说了,百度搜索通常比较麻烦。百度。 Com / xxxxx。

第二种方法是使用百度快照

这比使用搜索和空间的方法要好,但是前提是您的网页必须是百度收录,这也是百度的漏洞吗?如图所示,只需单击百度快照并复制地址即可。该列中的链接通常不会被百度贴吧删除,其他搜索引擎(如搜搜和360)也相同。

第三种方法是使用转发网络

此转发地址不是短URL,而是类似的1x。 网站之类的操作,如de,是因为您可以选择太多的URL后缀,而百度则无法全部识别。无论如何,没有诸如com,cn,net之类的后缀,并且我不会谈论具体细节。操作非常简单。该操作类似于URL小型化。创建一个新项目,然后您将获得一个免费的ftp空间。您可以使用ftp工具上传文件。这样,cpa很好,中文界面也很容易理解。

以前提交的全部都是数千个单词。这次,单词的数量很少,但是它们都是实用技能。希望对大家有帮助。我也希望给我留下一个链接。谢谢。 Wavebetter洗脸机

相关报告:

序言MongoDB上的先前操作始终是通过mongo客户程序执行的。但实际上,我们对MOngoDB数据的操作通常是通过更多

本文总结了实际应用中遇到的python字符编码问题,并制定了一组与编码有关的约定,以避免编码错误。编写平凡的书时,您需要总结对soj所做的问题,并准备在总结过程中通过soj编写解决方案。该解决方案在python中是可读的,也就是说,python可以直接评估该公式以便于处理。编写问题解决方案永远是更多 查看全部

揭示了在百度贴吧上保持链接的三种方法

百度贴吧的流量很大,但是基本上不可能通过常规渠道与网站建立链接。接下来,我将以我的亲身经历向您介绍。百度贴吧离开链接的3种方法是干货,哈哈,不只是百度贴吧。在百度之后,也有不同的方法可以做到这一点。好吧,我们不要再胡说八道了,转到话题:

第一种方法是使用百度的内在产品

百度的内部产品不过是百度空间和百度搜索。这个方法很简单。百度空间是百度的博客,它的权重很高。进行外部链接也很好。它类似于新浪和网易。自己写文章,我不会再说了,百度搜索通常比较麻烦。百度。 Com / xxxxx。

第二种方法是使用百度快照

这比使用搜索和空间的方法要好,但是前提是您的网页必须是百度收录,这也是百度的漏洞吗?如图所示,只需单击百度快照并复制地址即可。该列中的链接通常不会被百度贴吧删除,其他搜索引擎(如搜搜和360)也相同。

第三种方法是使用转发网络

此转发地址不是短URL,而是类似的1x。 网站之类的操作,如de,是因为您可以选择太多的URL后缀,而百度则无法全部识别。无论如何,没有诸如com,cn,net之类的后缀,并且我不会谈论具体细节。操作非常简单。该操作类似于URL小型化。创建一个新项目,然后您将获得一个免费的ftp空间。您可以使用ftp工具上传文件。这样,cpa很好,中文界面也很容易理解。

以前提交的全部都是数千个单词。这次,单词的数量很少,但是它们都是实用技能。希望对大家有帮助。我也希望给我留下一个链接。谢谢。 Wavebetter洗脸机

相关报告:

序言MongoDB上的先前操作始终是通过mongo客户程序执行的。但实际上,我们对MOngoDB数据的操作通常是通过更多

本文总结了实际应用中遇到的python字符编码问题,并制定了一组与编码有关的约定,以避免编码错误。编写平凡的书时,您需要总结对soj所做的问题,并准备在总结过程中通过soj编写解决方案。该解决方案在python中是可读的,也就是说,python可以直接评估该公式以便于处理。编写问题解决方案永远是更多

核心方法:PowerBI抓取网页技巧:提取网页中的链接

采集交流 • 优采云 发表了文章 • 0 个评论 • 416 次浏览 • 2020-08-31 14:06

关于Power BI从网页提取数据的技术,前几篇文章已经分享了其中的一些内容,您可以查看以下内容:

如何使用PowerBI批量抓取Web数据?

Power BI会获取“猫眼”数据来告诉您哪部电影更受欢迎?

提取网页中可见的标准化数据很容易,但是如何提取可以再次在网页上单击的链接?

实际上,这也非常简单. 本文以豆瓣阅读中的TOP250为例:

在此网页上,不仅会显示书籍标题,等级,作者和其他信息的列表,还可以单击封面或标题进入书籍的详细信息页面. 让我们看看如何提取此链接.

在PowerBI Desktop中,选择使用Web获取数据,您将看到此导航器,

<p>在表格视图中看不到可以提取的数据,这没关系,可以单击左下角的“使用示例添加表格”,然后可以看到此网页, 查看全部

PowerBI爬行网页技能: 提取网页中的链接

关于Power BI从网页提取数据的技术,前几篇文章已经分享了其中的一些内容,您可以查看以下内容:

如何使用PowerBI批量抓取Web数据?

Power BI会获取“猫眼”数据来告诉您哪部电影更受欢迎?

提取网页中可见的标准化数据很容易,但是如何提取可以再次在网页上单击的链接?

实际上,这也非常简单. 本文以豆瓣阅读中的TOP250为例:

在此网页上,不仅会显示书籍标题,等级,作者和其他信息的列表,还可以单击封面或标题进入书籍的详细信息页面. 让我们看看如何提取此链接.

在PowerBI Desktop中,选择使用Web获取数据,您将看到此导航器,

<p>在表格视图中看不到可以提取的数据,这没关系,可以单击左下角的“使用示例添加表格”,然后可以看到此网页,

解读:Python大佬精选教材,一步一步教你从零开始学会采集小说

采集交流 • 优采云 发表了文章 • 0 个评论 • 647 次浏览 • 2020-08-31 12:48

履带式实战01--小说02-2,开始页面处理02-3,页面处理03,其他内容分析: 03-3,其他04,完整代码05,结论:

01. 运行环境

您可以通过私人消息小编01获得Python学习材料

# 操作系统:win10 专业版

pycharm professional 2019.1

python 3.8

beautifulsoup4 == 4.9.0

requests == 2.23.0

random # 内置的

1234567

02,开始抓取02-1,分析点

对于其他两点,请先获取页面,然后获取页面内部的内容

02-1-1. 页面间处理: 找到采集器的第一页以找到上一页和下一页的规则,或者如何跳转到下一页以找到最后一页</p

p通常来说: 确定开始条件和结束条件,然后找到跳转到下一页的规则! (有一个开始,就有一个过程)02-1-2,提取页面内容以查找数据内容,(标题,内容...)(着重于查找内容的共性,易于提取)提取标签,然后提取文本以保存提取的数据02-2,开始页面处理02-2-1,文章目录链接地址:/p

ppre class="syl-page-code hljs less"codebrspan class="hljs-attribute"http/span:span class="hljs-comment"//www.quanben5.com/n/chuimianbuhanyangliufeng/xiaoshuo.html/spanbrspan class="hljs-comment"12/span/code/pre/p

p此地址是我们要检索的小说的目录页面的地址. 该页面具有我们要爬网的所有页面的链接地址,因此方便我们进行首页和末页以及页面之间的地址法./p

p02-2-2,第一页链接地址:/p

ppre class="syl-page-code hljs apache"codespan class="hljs-comment"# 第一个页面链接地址/spanbrspan class="hljs-comment"http://www.quanben5.com/n/chui ... rspan class="hljs-comment"12/span/code/pre/p

p02-2-3,第2-5页链接地址:/p

ppre class="syl-page-code hljs shell"codespan class="hljs-meta"#/spanspan class="bash" 第二个页面链接地址:/spanbrspan class="bash"http://www.quanben5.com/n/chui ... rspan class="bash"span class="hljs-comment"# 第三个页面链接地址:/span/spanbrspan class="bash"span class="hljs-comment"http://www.quanben5.com/n/chui ... rspan class="bash"span class="hljs-comment"# 第四个页面链接地址:/span/spanbrspan class="bash"span class="hljs-comment"http://www.quanben5.com/n/chui ... rspan class="bash"span class="hljs-comment"# 第五个页面链接地址:/span/spanbrspan class="bash"span class="hljs-comment"http://www.quanben5.com/n/chui ... rspan class="bash"span class="hljs-comment"12345678/span/span/code/pre/p

pimg src='https://p6-tt.byteimg.com/origin/pgc-image/c69a70ccbe854505822464c15308383c?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p02-2-4,最后一页的链接地址:/p

ppre class="syl-page-code hljs apache"codespan class="hljs-comment"# 最后一个页面链接地址:/spanbrspan class="hljs-comment"http://www.quanben5.com/n/chui ... rspan class="hljs-comment"12/span/code/pre/p

pimg src='https://p3-tt.byteimg.com/origin/pgc-image/f547f9cc75e747f9aaa0818cdd8aff5a?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p02-2-5. 分析结果/p

p从上面的链接地址中,我们可以看到这本小说的所有网页地址都是/p

p到/p

p结束了,我们可以将其与上一个进行比较/p

p*****. html都是一样的,只有最后五个值不同,并且每一页都有+1的变化规律,因此我们就知道了所有页面的规律起始条件和结束条件./p

p02-2-6. 获取所有页面的代码/p

ppre class="syl-page-code hljs ini"codespan class="hljs-attr"urllist/span = [span class="hljs-string"'http://www.quanben5.com/n/chuimianbuhanyangliufeng/{}.html'/span.format(page) for page in range(span class="hljs-number"17644/span,span class="hljs-number"17650/span)]br/code/pre/p

p此列表理解功能将所有页面保存在urllist列表中./p

p02-3,页面处理02-3-1,页面分析1/p

p打开文章,右键单击以检查!/p

pimg src='https://p1-tt.byteimg.com/origin/pgc-image/f5163b6ff6aa477a9818c62bfd941491?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p了解标签的内容所在的标签,单击代码左上角的小箭头,然后选择要在网页中查看内容的区域,然后在找到后进行分析//p

pimg src='https://p6-tt.byteimg.com/origin/pgc-image/34d521279aff407fa5bc7263b8ee7c58?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p02-3-2,文章标题分析:/p

pimg src='https://p3-tt.byteimg.com/origin/pgc-image/ce25ad97ba7342968abbe8e8cb6d863f?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p经过分析,标题是页面中唯一的标签,并且class ='title',我们通过标题的这两个特征获得标题,然后获取标题的内容. (获取标题,该标题是内容所必需的,并且还可以用作保存文件的文件名)/p

p02-3-3. 获取标题代码实现:/p

ppre class="syl-page-code hljs go"code response = requests.get(url=pageurl,headers=headers,params=params)br reshtml = response.content.decode()brbr soup = BeautifulSoup(reshtml,span class="hljs-string"'lxml'/span)br br # 获取页面的标题所在标签,用到了***层级选择器****br titlelist = soup.span class="hljs-keyword"select/span(span class="hljs-string"'.content h1'/span)br br # 获取标签里面的标题内容,因为标签是保存的一个列表里面,要先取出来,br # 然后用span class="hljs-string"`.get_text()`/span获取到其中的内容br title_text = titlelist[span class="hljs-number"0/span].get_text()br br # 替换到标题里面的一些特殊符号,后面保存为文件名的时候,不允许,br # 这一个是后面代码运行之中出的错误,后面加上的。br title_text =title_text.replace(span class="hljs-string"'*'/span,span class="hljs-string"''/span)/code/pre/p

p02-3-4. 获得内容分析:/p

pimg src='https://p3-tt.byteimg.com/origin/pgc-image/122b722a5b8f4514871b2239c5907cb3?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p通过分析,(见图),我们发现了以下几点:/p

p1. 小说的所有内容都在p标签中/p

p2. 此内容的p标签位于div标签中,其ID为“ content”./p

p基于以上两点,我们可以唯一地获取所有内容的p标签,然后将其获取到内部./p

p02-3-5,内容获取代码说明/p

ppre class="syl-page-code hljs cs"code response = requests.span class="hljs-keyword"get/span(url=pageurl,headers=headers,span class="hljs-keyword"params/span=span class="hljs-keyword"params/span)br reshtml = response.content.decode()brbr soup = BeautifulSoup(reshtml,span class="hljs-string"'lxml'/span)br span class="hljs-meta"# 获取到全部存在内容的标签,返回的是一个列表/spanbrspan class="hljs-meta" # 用到了***层级选择器***/spanbrspan class="hljs-meta" restextlist = soup.select('#content p')/spanbrspan class="hljs-meta" # 用for循环可以取出全部的标签,然后用.get_text()取出全部内容。/spanbrspan class="hljs-meta" for article_text in restextlist:/spanbrspan class="hljs-meta" article_text.get_text()/span/code/pre/p

p03. 其他内容分析: 03-1,标头请求标头/p

p在网页中,/p

p右键单击进行检查/p

p-----单击上方的网络/p

p----->检查保留日志

----->然后刷新页面

----->查找以“名称”刷新的消息(概率为“是”)(这是此网页,可以找到它)

----->单击右侧的标题信息

----->转到底部的请求标头请求标头信息

----->在其中找到User-Agent信息,然后将其复制并粘贴到代码中. 这里存储了很多信息. 如果您不携带它,则很有可能无法请求该网页.

03-2. 使用参数代理池的原因:

如果您快速且频繁地从相同的IP地址请求网站,则网站会将其视为恶意请求,进行抓取等,然后受到IP禁令等的限制. 让您不要抓取信息.

解决方案

使用代理池,(这是一个正向代理. 反向代理使用Nginx自己了解它. 前者是浏览器的代理,后者是服务器的代理. )然后选择从代理池中随机获取IP地址用于访问时,每次请求的IP地址都不同. 在这种情况下,另一方无法检测到异常.

快速代理

此网站收录大量免费的高秘密代理,可以使用,而对方无法检测到该ip!

03-3,其他

如果上面仍然不能请求该页面,那么您将继续在“请求标头”请求标头中继续携带该信息. 让其他人认为您是浏览器.

04,完整代码

import requests

from bs4 import BeautifulSoup

import random

# 全部网页列表,后面进行循环取出页面,然后处理

urllist = ['http://www.quanben5.com/n/chuimianbuhanyangliufeng/{}.html'.format(page) for page in range(17482,17650)]

# 请求头

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/84.0.4147.125 Safari/537.36"

}

# 正向代理,代理池。

# 如果一个ip地址,快速,一直请求的话,会被网页认为是爬虫,然后把你的ip地址封禁了。。所以用正向代理。。然后在下面用random模块,随机取出一个ip地址进行请求!

paramslist = ['121.232.199.237:9000','125.108.67.254:9000','123.163.118.102:9999',

'125.108.67.254:9000','171.35.172.151:9999','123.101.231.234:9999',

'125.108.67.254:9000','123.163.118.102:9999','171.35.172.151:9999',

'123.101.231.234:9999','113.195.16.16:9999','175.44.109.145:9999',

'125.108.85.141:9000','175.43.32.21:9999','183.166.103.22:9999',

'125.110.96.80:9000','123.160.69.100:9999','112.111.217.69:9999',

'1.199.30.133:9999','123.55.102.150:9999','120.83.104.196:9999',

'180.118.128.138:9000','163.204.95.253:9999','113.195.18.89:9999',

'113.195.16.191:9999','175.42.129.76:9999','125.110.124.214:9000',

'125.110.102.54:9000','36.249.119.16:9999','125.110.89.240:9000',

'171.35.146.70:9999','124.93.201.59:42672','171.35.173.112:9999']

# 从代理池里面,随机取出一个ip地址,进行访问

httpindex = random.randint(0,len(paramslist)-1)

params = {

'HTTP': paramslist[httpindex]

}

# for循环每一个列表,进行处理

for pageurl in urllist:

# 下面的两行就是看一个下载进度提示,没有意义

index1 = urllist.index(pageurl)+1

print("第{}下载".format(index1))

# 发送请求,获取页面

response = requests.get(url=pageurl,headers=headers,params=params)

reshtml = response.content.decode()

# 用bs4解析页面

soup = BeautifulSoup(reshtml,'lxml')

# 获取小说全部内容的标签

restextlist = soup.select('#content p')

# 获取小说标题的标签

titlelist = soup.select('.content h1')

# 获取标题的文字,然后进行特殊符号的替换,以免很后面文章命名文件出错

title_text = titlelist[0].get_text()

title_text =title_text.replace('*','')

print("正在下载---{}---".format(title_text))

# 打开文件,进行写入文章的全部的小说,文件命名就是“标题.txt”,写的方式'w',编码方式是'utf-8'

with open("./08novel/{}.txt".format(title_text),'w',encoding='utf-8') as f:

f.write(title_text+"\n")

# for循环获取的article_text 是带有内容的p标签

for article_text in restextlist:

# article_text.get_text()这一个才是p标签,获取其中的内容。换行

f.write(article_text.get_text()+"\n")

print("下载完成---{}---".format(title_text))

print("全部下载完成!")

05. 结论:

个人记录,初学者,了解更多,欢迎大家讨论! 查看全部

从Python大师中精选的教科书,逐步教您从头学习采摘小说

履带式实战01--小说02-2,开始页面处理02-3,页面处理03,其他内容分析: 03-3,其他04,完整代码05,结论:

01. 运行环境

您可以通过私人消息小编01获得Python学习材料

# 操作系统:win10 专业版

pycharm professional 2019.1

python 3.8

beautifulsoup4 == 4.9.0

requests == 2.23.0

random # 内置的

1234567

02,开始抓取02-1,分析点

对于其他两点,请先获取页面,然后获取页面内部的内容

02-1-1. 页面间处理: 找到采集器的第一页以找到上一页和下一页的规则,或者如何跳转到下一页以找到最后一页</p

p通常来说: 确定开始条件和结束条件,然后找到跳转到下一页的规则! (有一个开始,就有一个过程)02-1-2,提取页面内容以查找数据内容,(标题,内容...)(着重于查找内容的共性,易于提取)提取标签,然后提取文本以保存提取的数据02-2,开始页面处理02-2-1,文章目录链接地址:/p

ppre class="syl-page-code hljs less"codebrspan class="hljs-attribute"http/span:span class="hljs-comment"//www.quanben5.com/n/chuimianbuhanyangliufeng/xiaoshuo.html/spanbrspan class="hljs-comment"12/span/code/pre/p

p此地址是我们要检索的小说的目录页面的地址. 该页面具有我们要爬网的所有页面的链接地址,因此方便我们进行首页和末页以及页面之间的地址法./p

p02-2-2,第一页链接地址:/p

ppre class="syl-page-code hljs apache"codespan class="hljs-comment"# 第一个页面链接地址/spanbrspan class="hljs-comment"http://www.quanben5.com/n/chui ... rspan class="hljs-comment"12/span/code/pre/p

p02-2-3,第2-5页链接地址:/p

ppre class="syl-page-code hljs shell"codespan class="hljs-meta"#/spanspan class="bash" 第二个页面链接地址:/spanbrspan class="bash"http://www.quanben5.com/n/chui ... rspan class="bash"span class="hljs-comment"# 第三个页面链接地址:/span/spanbrspan class="bash"span class="hljs-comment"http://www.quanben5.com/n/chui ... rspan class="bash"span class="hljs-comment"# 第四个页面链接地址:/span/spanbrspan class="bash"span class="hljs-comment"http://www.quanben5.com/n/chui ... rspan class="bash"span class="hljs-comment"# 第五个页面链接地址:/span/spanbrspan class="bash"span class="hljs-comment"http://www.quanben5.com/n/chui ... rspan class="bash"span class="hljs-comment"12345678/span/span/code/pre/p

pimg src='https://p6-tt.byteimg.com/origin/pgc-image/c69a70ccbe854505822464c15308383c?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p02-2-4,最后一页的链接地址:/p

ppre class="syl-page-code hljs apache"codespan class="hljs-comment"# 最后一个页面链接地址:/spanbrspan class="hljs-comment"http://www.quanben5.com/n/chui ... rspan class="hljs-comment"12/span/code/pre/p

pimg src='https://p3-tt.byteimg.com/origin/pgc-image/f547f9cc75e747f9aaa0818cdd8aff5a?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p02-2-5. 分析结果/p

p从上面的链接地址中,我们可以看到这本小说的所有网页地址都是/p

p到/p

p结束了,我们可以将其与上一个进行比较/p

p*****. html都是一样的,只有最后五个值不同,并且每一页都有+1的变化规律,因此我们就知道了所有页面的规律起始条件和结束条件./p

p02-2-6. 获取所有页面的代码/p

ppre class="syl-page-code hljs ini"codespan class="hljs-attr"urllist/span = [span class="hljs-string"'http://www.quanben5.com/n/chuimianbuhanyangliufeng/{}.html'/span.format(page) for page in range(span class="hljs-number"17644/span,span class="hljs-number"17650/span)]br/code/pre/p

p此列表理解功能将所有页面保存在urllist列表中./p

p02-3,页面处理02-3-1,页面分析1/p

p打开文章,右键单击以检查!/p

pimg src='https://p1-tt.byteimg.com/origin/pgc-image/f5163b6ff6aa477a9818c62bfd941491?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p了解标签的内容所在的标签,单击代码左上角的小箭头,然后选择要在网页中查看内容的区域,然后在找到后进行分析//p

pimg src='https://p6-tt.byteimg.com/origin/pgc-image/34d521279aff407fa5bc7263b8ee7c58?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p02-3-2,文章标题分析:/p

pimg src='https://p3-tt.byteimg.com/origin/pgc-image/ce25ad97ba7342968abbe8e8cb6d863f?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p经过分析,标题是页面中唯一的标签,并且class ='title',我们通过标题的这两个特征获得标题,然后获取标题的内容. (获取标题,该标题是内容所必需的,并且还可以用作保存文件的文件名)/p

p02-3-3. 获取标题代码实现:/p

ppre class="syl-page-code hljs go"code response = requests.get(url=pageurl,headers=headers,params=params)br reshtml = response.content.decode()brbr soup = BeautifulSoup(reshtml,span class="hljs-string"'lxml'/span)br br # 获取页面的标题所在标签,用到了***层级选择器****br titlelist = soup.span class="hljs-keyword"select/span(span class="hljs-string"'.content h1'/span)br br # 获取标签里面的标题内容,因为标签是保存的一个列表里面,要先取出来,br # 然后用span class="hljs-string"`.get_text()`/span获取到其中的内容br title_text = titlelist[span class="hljs-number"0/span].get_text()br br # 替换到标题里面的一些特殊符号,后面保存为文件名的时候,不允许,br # 这一个是后面代码运行之中出的错误,后面加上的。br title_text =title_text.replace(span class="hljs-string"'*'/span,span class="hljs-string"''/span)/code/pre/p

p02-3-4. 获得内容分析:/p

pimg src='https://p3-tt.byteimg.com/origin/pgc-image/122b722a5b8f4514871b2239c5907cb3?from=pc' alt='Python大佬精选教材,一步一步教你从零开始学会采集小说'//p

p通过分析,(见图),我们发现了以下几点:/p

p1. 小说的所有内容都在p标签中/p

p2. 此内容的p标签位于div标签中,其ID为“ content”./p

p基于以上两点,我们可以唯一地获取所有内容的p标签,然后将其获取到内部./p

p02-3-5,内容获取代码说明/p

ppre class="syl-page-code hljs cs"code response = requests.span class="hljs-keyword"get/span(url=pageurl,headers=headers,span class="hljs-keyword"params/span=span class="hljs-keyword"params/span)br reshtml = response.content.decode()brbr soup = BeautifulSoup(reshtml,span class="hljs-string"'lxml'/span)br span class="hljs-meta"# 获取到全部存在内容的标签,返回的是一个列表/spanbrspan class="hljs-meta" # 用到了***层级选择器***/spanbrspan class="hljs-meta" restextlist = soup.select('#content p')/spanbrspan class="hljs-meta" # 用for循环可以取出全部的标签,然后用.get_text()取出全部内容。/spanbrspan class="hljs-meta" for article_text in restextlist:/spanbrspan class="hljs-meta" article_text.get_text()/span/code/pre/p

p03. 其他内容分析: 03-1,标头请求标头/p

p在网页中,/p

p右键单击进行检查/p

p-----单击上方的网络/p

p----->检查保留日志

----->然后刷新页面

----->查找以“名称”刷新的消息(概率为“是”)(这是此网页,可以找到它)

----->单击右侧的标题信息

----->转到底部的请求标头请求标头信息

----->在其中找到User-Agent信息,然后将其复制并粘贴到代码中. 这里存储了很多信息. 如果您不携带它,则很有可能无法请求该网页.

03-2. 使用参数代理池的原因:

如果您快速且频繁地从相同的IP地址请求网站,则网站会将其视为恶意请求,进行抓取等,然后受到IP禁令等的限制. 让您不要抓取信息.

解决方案

使用代理池,(这是一个正向代理. 反向代理使用Nginx自己了解它. 前者是浏览器的代理,后者是服务器的代理. )然后选择从代理池中随机获取IP地址用于访问时,每次请求的IP地址都不同. 在这种情况下,另一方无法检测到异常.

快速代理

此网站收录大量免费的高秘密代理,可以使用,而对方无法检测到该ip!

03-3,其他

如果上面仍然不能请求该页面,那么您将继续在“请求标头”请求标头中继续携带该信息. 让其他人认为您是浏览器.

04,完整代码

import requests

from bs4 import BeautifulSoup

import random

# 全部网页列表,后面进行循环取出页面,然后处理

urllist = ['http://www.quanben5.com/n/chuimianbuhanyangliufeng/{}.html'.format(page) for page in range(17482,17650)]

# 请求头

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/84.0.4147.125 Safari/537.36"

}

# 正向代理,代理池。

# 如果一个ip地址,快速,一直请求的话,会被网页认为是爬虫,然后把你的ip地址封禁了。。所以用正向代理。。然后在下面用random模块,随机取出一个ip地址进行请求!

paramslist = ['121.232.199.237:9000','125.108.67.254:9000','123.163.118.102:9999',

'125.108.67.254:9000','171.35.172.151:9999','123.101.231.234:9999',

'125.108.67.254:9000','123.163.118.102:9999','171.35.172.151:9999',

'123.101.231.234:9999','113.195.16.16:9999','175.44.109.145:9999',

'125.108.85.141:9000','175.43.32.21:9999','183.166.103.22:9999',

'125.110.96.80:9000','123.160.69.100:9999','112.111.217.69:9999',

'1.199.30.133:9999','123.55.102.150:9999','120.83.104.196:9999',

'180.118.128.138:9000','163.204.95.253:9999','113.195.18.89:9999',

'113.195.16.191:9999','175.42.129.76:9999','125.110.124.214:9000',

'125.110.102.54:9000','36.249.119.16:9999','125.110.89.240:9000',

'171.35.146.70:9999','124.93.201.59:42672','171.35.173.112:9999']

# 从代理池里面,随机取出一个ip地址,进行访问

httpindex = random.randint(0,len(paramslist)-1)

params = {

'HTTP': paramslist[httpindex]

}

# for循环每一个列表,进行处理

for pageurl in urllist:

# 下面的两行就是看一个下载进度提示,没有意义

index1 = urllist.index(pageurl)+1

print("第{}下载".format(index1))

# 发送请求,获取页面

response = requests.get(url=pageurl,headers=headers,params=params)

reshtml = response.content.decode()

# 用bs4解析页面

soup = BeautifulSoup(reshtml,'lxml')

# 获取小说全部内容的标签

restextlist = soup.select('#content p')

# 获取小说标题的标签

titlelist = soup.select('.content h1')

# 获取标题的文字,然后进行特殊符号的替换,以免很后面文章命名文件出错

title_text = titlelist[0].get_text()

title_text =title_text.replace('*','')

print("正在下载---{}---".format(title_text))

# 打开文件,进行写入文章的全部的小说,文件命名就是“标题.txt”,写的方式'w',编码方式是'utf-8'

with open("./08novel/{}.txt".format(title_text),'w',encoding='utf-8') as f:

f.write(title_text+"\n")

# for循环获取的article_text 是带有内容的p标签

for article_text in restextlist:

# article_text.get_text()这一个才是p标签,获取其中的内容。换行

f.write(article_text.get_text()+"\n")

print("下载完成---{}---".format(title_text))

print("全部下载完成!")

05. 结论:

个人记录,初学者,了解更多,欢迎大家讨论!

四步教你获取公众号历史文章链接 让你翻看更方便

采集交流 • 优采云 发表了文章 • 0 个评论 • 632 次浏览 • 2020-08-29 19:29

公众号的历史文章是特别多的,而且每位文章都会有一个专属链接,因此很多人都想知道历史文章链接怎么获取,下面我们追随拓途数据一起来了解一下获取公众号历史文章链接的相关资料吧。

获取公众号历史文章链接步骤一

首先,登录你的公众号后台帐号, 编辑文章,将光标逗留在你想添加链接的地方,点击右上角的超链接标示。

获取公众号历史文章链接

获取公众号历史文章链接步骤二

然后你会看见这样的页面,在公众号文章链接的分类下找到查找文章,也可以直接输入文章链接,这里添加的文章链接一定是你的这个帐号曾经发过的文章链接哦,而不是别的帐号里复制过来的链接哦。

获取公众号历史文章链接步骤三

点击查找公众号文章的话,可以直接从公众号列表上面找历史文章,往下滑查找更多。也可以点击下一页的标示进行多种选择,当你选择了一篇文章后,点击确定,然后会跳回到你的文章编辑页面,你会看见你所选择的那篇文章就在里面了。

获取公众号历史文章链接

获取公众号历史文章链接步骤四

当你用键盘单击那行文字的时侯,文章的会出现链接,你可以选择去除,然后再进行重新选择,也可以再其中做更改。发布文章成功之后,别人就可以点击这行文字直接步入你的历史文章啦!

相信看完了拓途数据的介绍以后,你对于怎样获取公众号历史文章链接早已有了一个全面的了解,那就赶快找到自己所须要的数据去实际操作一番吧!

更多资讯知识点可持续关注,后续还有公众号剖析必备网站、有哪些网站可以剖析公众号后台、分析一个公众号营运的网站、公众号文章采集神器有什么、微信公众号历史文章标题批量导入等知识点。 查看全部

四步教你获取公众号历史文章链接 让你翻看更方便

公众号的历史文章是特别多的,而且每位文章都会有一个专属链接,因此很多人都想知道历史文章链接怎么获取,下面我们追随拓途数据一起来了解一下获取公众号历史文章链接的相关资料吧。

获取公众号历史文章链接步骤一

首先,登录你的公众号后台帐号, 编辑文章,将光标逗留在你想添加链接的地方,点击右上角的超链接标示。

获取公众号历史文章链接

获取公众号历史文章链接步骤二

然后你会看见这样的页面,在公众号文章链接的分类下找到查找文章,也可以直接输入文章链接,这里添加的文章链接一定是你的这个帐号曾经发过的文章链接哦,而不是别的帐号里复制过来的链接哦。

获取公众号历史文章链接步骤三

点击查找公众号文章的话,可以直接从公众号列表上面找历史文章,往下滑查找更多。也可以点击下一页的标示进行多种选择,当你选择了一篇文章后,点击确定,然后会跳回到你的文章编辑页面,你会看见你所选择的那篇文章就在里面了。

获取公众号历史文章链接

获取公众号历史文章链接步骤四

当你用键盘单击那行文字的时侯,文章的会出现链接,你可以选择去除,然后再进行重新选择,也可以再其中做更改。发布文章成功之后,别人就可以点击这行文字直接步入你的历史文章啦!

相信看完了拓途数据的介绍以后,你对于怎样获取公众号历史文章链接早已有了一个全面的了解,那就赶快找到自己所须要的数据去实际操作一番吧!

更多资讯知识点可持续关注,后续还有公众号剖析必备网站、有哪些网站可以剖析公众号后台、分析一个公众号营运的网站、公众号文章采集神器有什么、微信公众号历史文章标题批量导入等知识点。

什么是订购链接、什么是黑链接

采集交流 • 优采云 发表了文章 • 0 个评论 • 288 次浏览 • 2020-08-28 10:54

购买链接也叫付费链接,就是以付费的方法,在别的网站上做自己网站的链接。与友情链接交换不一样的是,付费链接只有双向的指向,并不需要自己的网站链接回来。一般情况下,购买链接都是按月支付的,单个链接的订购价钱也不高,根据网站质量,大致每月几十元、上百元不等。

在订购链接风行以后,黑链骤然出现。黑链是SEO黑帽手法中相当普遍的一种手段,笼统地说.就是指一些人用非正常手段获取的其他网站的反向链接,最常见的黑链就是通过各类网站程序漏洞获取搜索引擎权重或则PR值较高的网站的WEBSHEL..进而在被黑网站上链接自己的网站。

简单来说,黑链的出现和风行就是由于出现了链接买卖概念。既然有很多不明所以的站长须要订购链接,自然会有人想尽办法为她们提供花钱的“机会”黑链的优点是在短时间内可以迅速提升排行,尤其对于这些新网站的站长来说,网站是新站,没有PR值,没有收录,和他人交换链接也很难。另外,购买黑链的人上面还有很大一部分垃圾站;长期不更新,到处采集,文章质量极低。这样的网站谁都不乐意和他交换友情链接—黑链的出现能够解决上述的问题,而且能带来权重特别高的双向链接,在短期内取得非常好的排行。

黑链的缺点是须要钱从金钱上来讲,有些站长并不适宜订购黑链,因为投入比较高。还有,既然是黑链,那肯定没法保证存在的长期性,所以黑链买卖的诚信度是毫无保障的。最后,搜索引擎对于这些对它们存在意义的“正面挑战”是十分敏感的,各种针对黑链、购买链接的判定方式层出不穷,并且惩罚力度也在逐步加强。 查看全部

什么是订购链接、什么是黑链接

购买链接也叫付费链接,就是以付费的方法,在别的网站上做自己网站的链接。与友情链接交换不一样的是,付费链接只有双向的指向,并不需要自己的网站链接回来。一般情况下,购买链接都是按月支付的,单个链接的订购价钱也不高,根据网站质量,大致每月几十元、上百元不等。

在订购链接风行以后,黑链骤然出现。黑链是SEO黑帽手法中相当普遍的一种手段,笼统地说.就是指一些人用非正常手段获取的其他网站的反向链接,最常见的黑链就是通过各类网站程序漏洞获取搜索引擎权重或则PR值较高的网站的WEBSHEL..进而在被黑网站上链接自己的网站。

简单来说,黑链的出现和风行就是由于出现了链接买卖概念。既然有很多不明所以的站长须要订购链接,自然会有人想尽办法为她们提供花钱的“机会”黑链的优点是在短时间内可以迅速提升排行,尤其对于这些新网站的站长来说,网站是新站,没有PR值,没有收录,和他人交换链接也很难。另外,购买黑链的人上面还有很大一部分垃圾站;长期不更新,到处采集,文章质量极低。这样的网站谁都不乐意和他交换友情链接—黑链的出现能够解决上述的问题,而且能带来权重特别高的双向链接,在短期内取得非常好的排行。

黑链的缺点是须要钱从金钱上来讲,有些站长并不适宜订购黑链,因为投入比较高。还有,既然是黑链,那肯定没法保证存在的长期性,所以黑链买卖的诚信度是毫无保障的。最后,搜索引擎对于这些对它们存在意义的“正面挑战”是十分敏感的,各种针对黑链、购买链接的判定方式层出不穷,并且惩罚力度也在逐步加强。

医院网站的建设要怎么样才最符合搜索引擎优化呢?

采集交流 • 优采云 发表了文章 • 0 个评论 • 171 次浏览 • 2020-08-28 05:15

医院网站的建设要怎么样才最符合搜索引擎优化呢?做网站优化的时有什么事项是须要注意的?

1、扬长避短、避免竞争

这里说的竞争,主要是指互联网上多如牛毛的同质化网站。很多民营医院创办了多家网站,但自己办的网站都有可能内部冲突,如某某整形医院早已有了自己的企业网站,同时又办了某甲整形网,除了页面不一样,栏目设置和内容几乎一致,更不用说互联网上成千上万家类似的网站了。同一篇文章能存在于数万家网站上,因此这样的网站建了也是枉费工夫,而且很多人也发觉了,自去年年初开始,百度对不做竞价的医疗网站收录的信息越来越少了。

2、正确掌握网站定位

对于医疗网站,医疗营销网建议逐一构建病种类别,每日转载癌症文章,这样的网站,每家诊所有一个就好了。既然要再办一家网站,就要和现今已有的内容分辨开,否则疗效就大大减慢了。同时我们还可以降低了文章发布内容,或许有博友就该问了,那我们要给网友提供哪些呢?互动!互动主要包括峰会、问答等栏目,也是个很难操控的东西,因为内容为网友自由发布,有关部门管的太严,也很容易出事。但搜索引擎喜欢,本地化的互动社区网友也喜欢。

3、医疗关键词的选择

民营医院网站作为诊所网路营销最重要的一个平台,如果方向不明晰、关键词配置不合理,将造成先天性的缺陷,最终造成项目失败。排名关键词没人搜索、有搜索的没转化率,排名疗效不好、投入大量资本,回报率低等,这些都是没有进行关键词剖析研究形成的问题,这些问题都是我们做为医疗SEO要注意的重点。

4、切忌频繁修改网页标题

网站页面的标题标签(TITLE)是大多数搜索引擎(尤其是百度)匹配关键词的核心点,搜索引擎依赖title标签进行切词、分词构建索引数据库,这是最原创阶段的搜索引擎排名的核心点,如今搜索引擎在技术上早已有了很大的进步,但是title还是提升用户体验的一个关键点,频繁的修改网站的title,搜索引擎会当作网站不稳定或者恶意的误导行为,当做作弊处理,所以网站页面的title要慎重。

5、切忌大量采集文章

对于与互联网中高度重复的文章,搜索引擎不太容易收录,即使收录了也不会给与好的排行,大量的采集文章对整站的信用平分十分不利。医院的网站建设完成后若果也大量采集其他诊所的文章,没有自己诊所相关信息,没有实质内容,对用户没有任何价值,给搜索引擎留下了不好的印象,也给搜索引擎优化带来了不少风险。

6、过分追求美观

爱美之心人皆有之,医院领导人审美情趣尤为浓重,一味追求网站美感,大气、好看、美观,这些都是诊所管理人员俗不可耐的表现。它早已偏离了网站建设最为核心的功能,就是网路营销,一切皆应当以营销疗效为首要,简洁明了的页面能够给用户良好的视觉体验。大量的使用图片、太多的flash导致页面容积过大,页面加载速率慢,使网站的可用性大打折扣,用户忍让度是有限的。还有最不利于SEO的导航使用图片作链接,搜索引擎不好辨识网站结构。

7、页面标题高度重复

网页的标题就是网页内容的概括,keywords相对来说是网页“特征”,Deion是网页的描述。网站优化要帮助搜索引擎区别开网站的任何的网页,减少页面的相似度。应该给每位页面取不同的标题,这样才能获得不同关键词的排行。

8、站群互链

民营医院网站的首页是权重最高的页面,关键词最容易获得排行,大多数诊所站长都在网站首页放置了大量的热门关键词,由于首页的位置有限,远远达不到诸多关键词的需求,许多站长都做了许多的小站,将部份热门关键词分离下来,这是一种干扰搜索引擎排行的行为,搜索引擎也对这样的行为采取了一定的举措。

9、频繁删掉文章造成大量死链接

民营医院内部的管理,经常会删掉一些网站栏目、文章等,删除的页面会形成大量的死链接。医院网站要做好404错误页面设置,删除页面的时侯尽量保留页面,在原有的页面上进行修改,删除之后要做好网站页面的更新。

10、复制网站

民营医院为了图建网站省钱省力,直接胡须眼睛一把抓,把现有的网站程序模板直接用来使用。这样就下来了两个相似度很高的网站,这样的新站很难得到好的排行,老站也会遭到连带影响。

11、商务通的设置

进入页面不能马上客服弹窗满天飞,医疗营销网建议最好设置弹出时间,一般网站首页是5-10秒,文章页面可以不使用弹出的而专用导航式的客服,或者设置浏览时间1分钟弹出。根据我多年做医疗网站优化的经验,一个网站咨询转化率并不在于你商务通设置的多少,更多的是在于你网站的布局结构,关于这点,我曾在医疗营销网网站的《如何能够提升诊所网路咨询的转化率》做过详尽的介绍,具体你们可以去查看一下。

12、客服的培训

我们首先要保证的,就是客服通信的畅通。不说24小时值守,但是你的流量高峰期和中期都应当有充足的在线客服。首先对咨询者应尽量留下病人的联系方法和姓名,如果能当场预约更好。其次,客服应主动寻问和提供选择性问题,让病人有良好的体验,产生信任感。主要针对病况,病史,以及出现的病症展开咨询和追问,拉近与病人的关系。

华企商城更多商品介绍:静海网站建设公司 淮北响应式网站开发大兴安岭H5响应式网站建设开发 查看全部

医院网站的建设要怎么样才最符合搜索引擎优化呢?

医院网站的建设要怎么样才最符合搜索引擎优化呢?做网站优化的时有什么事项是须要注意的?

1、扬长避短、避免竞争

这里说的竞争,主要是指互联网上多如牛毛的同质化网站。很多民营医院创办了多家网站,但自己办的网站都有可能内部冲突,如某某整形医院早已有了自己的企业网站,同时又办了某甲整形网,除了页面不一样,栏目设置和内容几乎一致,更不用说互联网上成千上万家类似的网站了。同一篇文章能存在于数万家网站上,因此这样的网站建了也是枉费工夫,而且很多人也发觉了,自去年年初开始,百度对不做竞价的医疗网站收录的信息越来越少了。

2、正确掌握网站定位

对于医疗网站,医疗营销网建议逐一构建病种类别,每日转载癌症文章,这样的网站,每家诊所有一个就好了。既然要再办一家网站,就要和现今已有的内容分辨开,否则疗效就大大减慢了。同时我们还可以降低了文章发布内容,或许有博友就该问了,那我们要给网友提供哪些呢?互动!互动主要包括峰会、问答等栏目,也是个很难操控的东西,因为内容为网友自由发布,有关部门管的太严,也很容易出事。但搜索引擎喜欢,本地化的互动社区网友也喜欢。

3、医疗关键词的选择

民营医院网站作为诊所网路营销最重要的一个平台,如果方向不明晰、关键词配置不合理,将造成先天性的缺陷,最终造成项目失败。排名关键词没人搜索、有搜索的没转化率,排名疗效不好、投入大量资本,回报率低等,这些都是没有进行关键词剖析研究形成的问题,这些问题都是我们做为医疗SEO要注意的重点。

4、切忌频繁修改网页标题

网站页面的标题标签(TITLE)是大多数搜索引擎(尤其是百度)匹配关键词的核心点,搜索引擎依赖title标签进行切词、分词构建索引数据库,这是最原创阶段的搜索引擎排名的核心点,如今搜索引擎在技术上早已有了很大的进步,但是title还是提升用户体验的一个关键点,频繁的修改网站的title,搜索引擎会当作网站不稳定或者恶意的误导行为,当做作弊处理,所以网站页面的title要慎重。

5、切忌大量采集文章

对于与互联网中高度重复的文章,搜索引擎不太容易收录,即使收录了也不会给与好的排行,大量的采集文章对整站的信用平分十分不利。医院的网站建设完成后若果也大量采集其他诊所的文章,没有自己诊所相关信息,没有实质内容,对用户没有任何价值,给搜索引擎留下了不好的印象,也给搜索引擎优化带来了不少风险。

6、过分追求美观

爱美之心人皆有之,医院领导人审美情趣尤为浓重,一味追求网站美感,大气、好看、美观,这些都是诊所管理人员俗不可耐的表现。它早已偏离了网站建设最为核心的功能,就是网路营销,一切皆应当以营销疗效为首要,简洁明了的页面能够给用户良好的视觉体验。大量的使用图片、太多的flash导致页面容积过大,页面加载速率慢,使网站的可用性大打折扣,用户忍让度是有限的。还有最不利于SEO的导航使用图片作链接,搜索引擎不好辨识网站结构。

7、页面标题高度重复

网页的标题就是网页内容的概括,keywords相对来说是网页“特征”,Deion是网页的描述。网站优化要帮助搜索引擎区别开网站的任何的网页,减少页面的相似度。应该给每位页面取不同的标题,这样才能获得不同关键词的排行。

8、站群互链

民营医院网站的首页是权重最高的页面,关键词最容易获得排行,大多数诊所站长都在网站首页放置了大量的热门关键词,由于首页的位置有限,远远达不到诸多关键词的需求,许多站长都做了许多的小站,将部份热门关键词分离下来,这是一种干扰搜索引擎排行的行为,搜索引擎也对这样的行为采取了一定的举措。

9、频繁删掉文章造成大量死链接

民营医院内部的管理,经常会删掉一些网站栏目、文章等,删除的页面会形成大量的死链接。医院网站要做好404错误页面设置,删除页面的时侯尽量保留页面,在原有的页面上进行修改,删除之后要做好网站页面的更新。

10、复制网站

民营医院为了图建网站省钱省力,直接胡须眼睛一把抓,把现有的网站程序模板直接用来使用。这样就下来了两个相似度很高的网站,这样的新站很难得到好的排行,老站也会遭到连带影响。

11、商务通的设置

进入页面不能马上客服弹窗满天飞,医疗营销网建议最好设置弹出时间,一般网站首页是5-10秒,文章页面可以不使用弹出的而专用导航式的客服,或者设置浏览时间1分钟弹出。根据我多年做医疗网站优化的经验,一个网站咨询转化率并不在于你商务通设置的多少,更多的是在于你网站的布局结构,关于这点,我曾在医疗营销网网站的《如何能够提升诊所网路咨询的转化率》做过详尽的介绍,具体你们可以去查看一下。

12、客服的培训

我们首先要保证的,就是客服通信的畅通。不说24小时值守,但是你的流量高峰期和中期都应当有充足的在线客服。首先对咨询者应尽量留下病人的联系方法和姓名,如果能当场预约更好。其次,客服应主动寻问和提供选择性问题,让病人有良好的体验,产生信任感。主要针对病况,病史,以及出现的病症展开咨询和追问,拉近与病人的关系。

华企商城更多商品介绍:静海网站建设公司 淮北响应式网站开发大兴安岭H5响应式网站建设开发

dedecms5.7怎样实现文章标题直接链接外部链接

采集交流 • 优采云 发表了文章 • 0 个评论 • 192 次浏览 • 2020-08-27 21:05

菜鸟一个, 用DedeCms5.7,自己设计模板,网站建成后已上线近一年。中间有一频道(栏目)称“媒体聚焦”,一直都是采集省市媒体和本区相关稿件。今年来了一新领导,可能觉得这种稿件在本地网站转发就不权威了,要求这个栏目的文章标题都指向原发布稿件的省市新闻网站,打开这种文章的标题直接就进外部网站。本来这通常是站长尽量避开的,但领导、客户如此要求,也不能不照做。 并且,我用网上搜索方式,比如 ”倚天网络“”(;cellspacing="0" cellpadding="0">

阅读权限:

发布选项:

生成HTML 仅动态浏览

所以,没有办法根据这个贴子的指引更改内容。后来想,DedeCms5.7更改比较大,在article_add.htm模板文件应当有吧。找到后更改了,在相应的位置加了该贴要求加的代码

转向网址:

但是,后面还要求更改action_archives_save.php和action_archives_edit_save.php两个文件的代码,但是这两个文件,我没法在DedeCms5.7内容管理系统找到。所以,请诸位高手能给与帮助,是不是对于DedeCms5.7,这个贴子说的方式就不适用了。现在 要实现该功能是否有新的方式,请大侠们指教。 查看全部

dedecms5.7怎样实现文章标题直接链接外部链接

菜鸟一个, 用DedeCms5.7,自己设计模板,网站建成后已上线近一年。中间有一频道(栏目)称“媒体聚焦”,一直都是采集省市媒体和本区相关稿件。今年来了一新领导,可能觉得这种稿件在本地网站转发就不权威了,要求这个栏目的文章标题都指向原发布稿件的省市新闻网站,打开这种文章的标题直接就进外部网站。本来这通常是站长尽量避开的,但领导、客户如此要求,也不能不照做。 并且,我用网上搜索方式,比如 ”倚天网络“”(;cellspacing="0" cellpadding="0">

阅读权限:

发布选项:

生成HTML 仅动态浏览

所以,没有办法根据这个贴子的指引更改内容。后来想,DedeCms5.7更改比较大,在article_add.htm模板文件应当有吧。找到后更改了,在相应的位置加了该贴要求加的代码

转向网址:

但是,后面还要求更改action_archives_save.php和action_archives_edit_save.php两个文件的代码,但是这两个文件,我没法在DedeCms5.7内容管理系统找到。所以,请诸位高手能给与帮助,是不是对于DedeCms5.7,这个贴子说的方式就不适用了。现在 要实现该功能是否有新的方式,请大侠们指教。

Python网路数据采集之HTML解析|第01天

采集交流 • 优采云 发表了文章 • 0 个评论 • 337 次浏览 • 2020-08-27 09:27

User:你好我是森林

Date:2018-03-29

Mark:《Python网路数据采集》

网络采集系列文章

Python网路数据采集之创建爬虫

Python网路数据采集之HTML解析

开始采集

网络爬虫是可以按照递归方法。为了找到URL 链接,它们必须首先获取网页内容,检查这个页面的内容,再找寻另一个 URL,然后获取 URL对应的网页内容,不断循环这一过程。

遍历单个域名

以抓取维基百科的Kevin Baco为例,实现简单的数据爬取。代码如下:

from urllib.request import urlopen

from bs4 import BeautifulSoup

html = urlopen('http://en.wikipedia.org/wiki/Kevin_Bacon')

bs = BeautifulSoup(html, 'html.parser')

for link in bs.find_all('a'):

if 'href' in link.attrs:

print(link.attrs['href'])

上述代码就获取维基百科网站的任何页面并提取页面链接。去掉我们不需要的词条,进行改进获取词条链接。代码如下:

from urllib.request import urlopen

from bs4 import BeautifulSoup

import re

html = urlopen('http://en.wikipedia.org/wiki/Kevin_Bacon')

bs = BeautifulSoup(html, 'html.parser')

for link in bs.find('div', {'id':'bodyContent'}).find_all(

'a', href=re.compile('^(/wiki/)((?!:).)*$')):

if 'href' in link.attrs:

print(link.attrs['href'])

如果我们要做到一个函数getLinks,可以用维基百科词条/wiki/方式的URL链接作为参数,然后以同样的方式返回一个列表,里面收录所有的词条 URL 链接。一个主函数,以某个起始词条为参数调用getLinks,再从返回的URL列表里随机选择一个词条链接,再调用 getLinks,直到我们主动停止,或者在新的页面上没有词条链接了,程序才停止运行。

完善后代码如下:

from urllib.request import urlopen

from bs4 import BeautifulSoup

import datetime

import random

import re

random.seed(datetime.datetime.now())

def getLinks(articleUrl):

html = urlopen('http://en.wikipedia.org{}'.format(articleUrl))

bs = BeautifulSoup(html, 'html.parser')

return bs.find('div', {'id':'bodyContent'}).find_all('a', href=re.compile('^(/wiki/)((?!:).)*$'))

links = getLinks('/wiki/Kevin_Bacon')

while len(links) > 0:

newArticle = links[random.randint(0, len(links)-1)].attrs['href']

print(newArticle)

links = getLinks(newArticle)

遍历整个网路

采集整个网站,那是十分花费显存资源的过程,尤其是处理小型网站时,最合适的工具就是用一个数据库来存储采集的资源。

遍历整个网路的数据益处:可以生产网站地图,采集网站数据等。但是通常不会消耗大量的显存资源去做采集,本节的意义不大。

通过互联网采集

建立网路地图,需要从一个链接跳转到另一个链接,逐步完善网站的地图信息,从而达到一个合适的网站地图,于此同时我们也不能忽视外链,从一个链接跳转到另一个链接的场景也会时有发生。相比之前的单域名采集,互联网采集的难度要高好多,所以,要求我们的找寻信息的方法和采集信息的方法都应当极具灵活性,以此达到理想的采集效果。

在做数据采集之前最好才能确定自己采集的内容,明确目标,然后按照目标的展示方式去剖析,该网站是否会跳转其他的链接,是否须要继续采集等各个诱因。

如果采集一个网站,有时候也会考虑到网路重定向的问题,例如我的个人博客原先链接是:,但是我做了一个网路的重定向,我将,重定向到原先的链接,这样无论是访问哪一个链接其本质都跳转到原先的链接,此时须要了解的是网路重定向的时侯,我们采集的URL地址会发生变化,在Python3.X的版本中,我们的urllib会帮我完成重定向的功能。

用Scrapy采集

Scrapy就是一个可以大幅度增加我们对网页链接查找和辨识工作复杂度的Python 库,它可以使你轻松地采集一个或多个域名的信息。

利用Scrapy进行爬虫项目还是有一些设置,我们可以采用官网下载,也可以采用pip进行安装,检验安装的方式在之前的Python基础系列的文章有提及过。这里不做过多的探讨。

创建一个项目:

➜ python scrapy startproject demourl

New Scrapy project 'demourl', using template directory '/usr/local/lib/python3.6/site-packages/scrapy/templates/project', created in:

/Users/demo/Project/python/demourl

You can start your first spider with:

cd demourl

scrapy genspider example example.com

我们查看一下目录结构:

➜ demourl tree ./

./

├── [drwxr-xr-x] demourl

│ ├── [-rw-r--r--] __init__.py

│ ├── [drwxr-xr-x] __pycache__

│ ├── [-rw-r--r--] items.py

│ ├── [-rw-r--r--] middlewares.py

│ ├── [-rw-r--r--] pipelines.py

│ ├── [-rw-r--r--] settings.py

│ └── [drwxr-xr-x] spiders

│ ├── [-rw-r--r--] __init__.py

│ └── [drwxr-xr-x] __pycache__

└── [-rw-r--r--] scrapy.cfg

4 directories, 7 files

关于Scrapy的内容我们后续逐一介绍,大家可以点击关注,及时收到后续更新。

博客原文链接: 查看全部

Python网路数据采集之HTML解析|第01天

User:你好我是森林

Date:2018-03-29

Mark:《Python网路数据采集》

网络采集系列文章

Python网路数据采集之创建爬虫

Python网路数据采集之HTML解析

开始采集

网络爬虫是可以按照递归方法。为了找到URL 链接,它们必须首先获取网页内容,检查这个页面的内容,再找寻另一个 URL,然后获取 URL对应的网页内容,不断循环这一过程。

遍历单个域名

以抓取维基百科的Kevin Baco为例,实现简单的数据爬取。代码如下:

from urllib.request import urlopen

from bs4 import BeautifulSoup

html = urlopen('http://en.wikipedia.org/wiki/Kevin_Bacon')

bs = BeautifulSoup(html, 'html.parser')

for link in bs.find_all('a'):

if 'href' in link.attrs:

print(link.attrs['href'])

上述代码就获取维基百科网站的任何页面并提取页面链接。去掉我们不需要的词条,进行改进获取词条链接。代码如下:

from urllib.request import urlopen

from bs4 import BeautifulSoup

import re

html = urlopen('http://en.wikipedia.org/wiki/Kevin_Bacon')

bs = BeautifulSoup(html, 'html.parser')

for link in bs.find('div', {'id':'bodyContent'}).find_all(

'a', href=re.compile('^(/wiki/)((?!:).)*$')):

if 'href' in link.attrs:

print(link.attrs['href'])

如果我们要做到一个函数getLinks,可以用维基百科词条/wiki/方式的URL链接作为参数,然后以同样的方式返回一个列表,里面收录所有的词条 URL 链接。一个主函数,以某个起始词条为参数调用getLinks,再从返回的URL列表里随机选择一个词条链接,再调用 getLinks,直到我们主动停止,或者在新的页面上没有词条链接了,程序才停止运行。

完善后代码如下:

from urllib.request import urlopen

from bs4 import BeautifulSoup

import datetime

import random

import re

random.seed(datetime.datetime.now())

def getLinks(articleUrl):

html = urlopen('http://en.wikipedia.org{}'.format(articleUrl))

bs = BeautifulSoup(html, 'html.parser')

return bs.find('div', {'id':'bodyContent'}).find_all('a', href=re.compile('^(/wiki/)((?!:).)*$'))

links = getLinks('/wiki/Kevin_Bacon')

while len(links) > 0:

newArticle = links[random.randint(0, len(links)-1)].attrs['href']

print(newArticle)

links = getLinks(newArticle)

遍历整个网路

采集整个网站,那是十分花费显存资源的过程,尤其是处理小型网站时,最合适的工具就是用一个数据库来存储采集的资源。

遍历整个网路的数据益处:可以生产网站地图,采集网站数据等。但是通常不会消耗大量的显存资源去做采集,本节的意义不大。

通过互联网采集

建立网路地图,需要从一个链接跳转到另一个链接,逐步完善网站的地图信息,从而达到一个合适的网站地图,于此同时我们也不能忽视外链,从一个链接跳转到另一个链接的场景也会时有发生。相比之前的单域名采集,互联网采集的难度要高好多,所以,要求我们的找寻信息的方法和采集信息的方法都应当极具灵活性,以此达到理想的采集效果。

在做数据采集之前最好才能确定自己采集的内容,明确目标,然后按照目标的展示方式去剖析,该网站是否会跳转其他的链接,是否须要继续采集等各个诱因。

如果采集一个网站,有时候也会考虑到网路重定向的问题,例如我的个人博客原先链接是:,但是我做了一个网路的重定向,我将,重定向到原先的链接,这样无论是访问哪一个链接其本质都跳转到原先的链接,此时须要了解的是网路重定向的时侯,我们采集的URL地址会发生变化,在Python3.X的版本中,我们的urllib会帮我完成重定向的功能。

用Scrapy采集

Scrapy就是一个可以大幅度增加我们对网页链接查找和辨识工作复杂度的Python 库,它可以使你轻松地采集一个或多个域名的信息。

利用Scrapy进行爬虫项目还是有一些设置,我们可以采用官网下载,也可以采用pip进行安装,检验安装的方式在之前的Python基础系列的文章有提及过。这里不做过多的探讨。

创建一个项目:

➜ python scrapy startproject demourl

New Scrapy project 'demourl', using template directory '/usr/local/lib/python3.6/site-packages/scrapy/templates/project', created in:

/Users/demo/Project/python/demourl

You can start your first spider with:

cd demourl

scrapy genspider example example.com

我们查看一下目录结构:

➜ demourl tree ./

./

├── [drwxr-xr-x] demourl

│ ├── [-rw-r--r--] __init__.py

│ ├── [drwxr-xr-x] __pycache__

│ ├── [-rw-r--r--] items.py

│ ├── [-rw-r--r--] middlewares.py

│ ├── [-rw-r--r--] pipelines.py

│ ├── [-rw-r--r--] settings.py

│ └── [drwxr-xr-x] spiders

│ ├── [-rw-r--r--] __init__.py

│ └── [drwxr-xr-x] __pycache__

└── [-rw-r--r--] scrapy.cfg

4 directories, 7 files

关于Scrapy的内容我们后续逐一介绍,大家可以点击关注,及时收到后续更新。

博客原文链接:

网站外部链接怎样做?

采集交流 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2020-08-27 09:25

网站外链是关键词排行的关键诱因,是做seo不可或缺的一环,做网站外部链接的形式有很多,找准适宜自己的。怎么为网站建设合适的外链?有以下方式。 注意,人工干预的,自然下降的链接最为有效。从人工干预的角度讲,我们要掌握锚文本 […]

网站外链是关键词排行的关键诱因,是做seo不可或缺的一环,做网站外部链接的形式有很多,找准适宜自己的。怎么为网站建设合适的外链?有以下方式。

注意,人工干预的,自然下降的链接最为有效。从人工干预的角度讲,我们要掌握锚文本链接,超级链接,白链接的占比,要掌握主要锚文本和次要锚文本的占比;从自然下降的角度来讲,通过满足用户需求的内容所获得的链接最为理想。

用心留言

现在,搜索引擎特别是百度早已将峰会,博客上面的链接权重传递作用弱化了,但若果你在峰会中,或在博客中,用心回复主题,用心编辑留言,那么会提高你签名的点击量与点击量,积少成多的点击会使你的峰会签名外链,博客留言外链作用更大。没有关注的贴子外链,留言外链都会对网站优化有相反作用。

文章发布

高质量的文章不仅要在本网站发布,还要在相关行业网站发布。有很多采集类站点,会有规律的采集相关内容,它们通过采集的形式组织内容,在采集的结果中,就会有部份网站留下你网站的文章链接。

类似于提供小工具在线使用功能

在你的网站上面,放一些使用方便的小程序,如关键词密度查询,seo综合查询等在线小工具,如果你的这种小工具能着力为用户提供便捷快捷的查询服务,那么是有很多网站愿意在她们网站放置你的网站链接的。

提供模板,插件等免费下载功能

绚丽实用的模板,功能齐全的插件也能满足用户特定需求,此类方式十分有效。以峰会程序Discuz为例,它们是不会为自己网站建设外链的,它们的外链都是用户自然为它们建设的,原因在于这个程序帮助了很多人,它们是善意的回报。

博客建设

博客内容质量的高低能决定其传播的范围,专心建设的博客能得到很多人的偏爱,通过原创的,受众大的内容帮助到细分访客,外链也会自然降低。

为网站做外部链接的方式举不胜举,找到更高效的,是最终目的。 查看全部

网站外部链接怎样做?

网站外链是关键词排行的关键诱因,是做seo不可或缺的一环,做网站外部链接的形式有很多,找准适宜自己的。怎么为网站建设合适的外链?有以下方式。 注意,人工干预的,自然下降的链接最为有效。从人工干预的角度讲,我们要掌握锚文本 […]

网站外链是关键词排行的关键诱因,是做seo不可或缺的一环,做网站外部链接的形式有很多,找准适宜自己的。怎么为网站建设合适的外链?有以下方式。

注意,人工干预的,自然下降的链接最为有效。从人工干预的角度讲,我们要掌握锚文本链接,超级链接,白链接的占比,要掌握主要锚文本和次要锚文本的占比;从自然下降的角度来讲,通过满足用户需求的内容所获得的链接最为理想。

用心留言

现在,搜索引擎特别是百度早已将峰会,博客上面的链接权重传递作用弱化了,但若果你在峰会中,或在博客中,用心回复主题,用心编辑留言,那么会提高你签名的点击量与点击量,积少成多的点击会使你的峰会签名外链,博客留言外链作用更大。没有关注的贴子外链,留言外链都会对网站优化有相反作用。

文章发布

高质量的文章不仅要在本网站发布,还要在相关行业网站发布。有很多采集类站点,会有规律的采集相关内容,它们通过采集的形式组织内容,在采集的结果中,就会有部份网站留下你网站的文章链接。

类似于提供小工具在线使用功能

在你的网站上面,放一些使用方便的小程序,如关键词密度查询,seo综合查询等在线小工具,如果你的这种小工具能着力为用户提供便捷快捷的查询服务,那么是有很多网站愿意在她们网站放置你的网站链接的。

提供模板,插件等免费下载功能

绚丽实用的模板,功能齐全的插件也能满足用户特定需求,此类方式十分有效。以峰会程序Discuz为例,它们是不会为自己网站建设外链的,它们的外链都是用户自然为它们建设的,原因在于这个程序帮助了很多人,它们是善意的回报。

博客建设

博客内容质量的高低能决定其传播的范围,专心建设的博客能得到很多人的偏爱,通过原创的,受众大的内容帮助到细分访客,外链也会自然降低。

为网站做外部链接的方式举不胜举,找到更高效的,是最终目的。

「seo教程」网站外部链接怎样做?

采集交流 • 优采云 发表了文章 • 0 个评论 • 169 次浏览 • 2020-08-27 04:50

网站外链是关键词排行的关键诱因,是做seo不可或缺的一环,做网站外部链接的形式有很多,找准适宜自己的。怎么为网站建设合适的外链?有以下方式。

注意,人工干预的,自然下降的链接最为有效。从人工干预的角度讲,我们要掌握锚文本链接,超级链接,白链接的占比,要掌握主要锚文本和次要锚文本的占比;从自然下降的角度来讲,通过满足用户需求的内容所获得的链接最为理想。

用心留言

现在,搜索引擎特别是百度早已将峰会,博客上面的链接权重传递作用弱化了,但若果你在峰会中,或在博客中,用心回复主题,用心编辑留言,那么会提高你签名的点击量与点击量,积少成多的点击会使你的峰会签名外链,博客留言外链作用更大。没有关注的贴子外链,留言外链都会对重庆网站优化有相反作用。

文章发布

高质量的文章不仅要在本网站发布,还要在相关行业网站发布。有很多采集类站点,会有规律的采集相关内容,它们通过采集的形式组织内容,在采集的结果中,就会有部份网站留下你网站的文章链接。

类似于提供小工具在线使用功能

在你的网站上面,放一些使用方便的小程序,如关键词密度查询,seo综合查询等在线小工具,如果你的这种小工具能着力为用户提供便捷快捷的查询服务,那么是有很多网站愿意在她们网站放置你的网站链接的。

提供模板,插件等免费下载功能

绚丽实用的模板,功能齐全的插件也能满足用户特定需求,此类方式十分有效。以峰会程序Discuz为例,它们是不会为自己网站建设外链的,它们的外链都是用户自然为它们建设的,原因在于这个程序帮助了很多人,它们是善意的回报。

博客建设

博客内容质量的高低能决定其传播的范围,专心建设的博客能得到很多人的追捧,通过原创的,受众大的内容帮助到细分访客,外链也会自然降低。

为网站做外部链接的方式举不胜举,找到更高效的,是最终目的。 查看全部

「seo教程」网站外部链接怎样做?

网站外链是关键词排行的关键诱因,是做seo不可或缺的一环,做网站外部链接的形式有很多,找准适宜自己的。怎么为网站建设合适的外链?有以下方式。

注意,人工干预的,自然下降的链接最为有效。从人工干预的角度讲,我们要掌握锚文本链接,超级链接,白链接的占比,要掌握主要锚文本和次要锚文本的占比;从自然下降的角度来讲,通过满足用户需求的内容所获得的链接最为理想。

用心留言

现在,搜索引擎特别是百度早已将峰会,博客上面的链接权重传递作用弱化了,但若果你在峰会中,或在博客中,用心回复主题,用心编辑留言,那么会提高你签名的点击量与点击量,积少成多的点击会使你的峰会签名外链,博客留言外链作用更大。没有关注的贴子外链,留言外链都会对重庆网站优化有相反作用。

文章发布

高质量的文章不仅要在本网站发布,还要在相关行业网站发布。有很多采集类站点,会有规律的采集相关内容,它们通过采集的形式组织内容,在采集的结果中,就会有部份网站留下你网站的文章链接。

类似于提供小工具在线使用功能

在你的网站上面,放一些使用方便的小程序,如关键词密度查询,seo综合查询等在线小工具,如果你的这种小工具能着力为用户提供便捷快捷的查询服务,那么是有很多网站愿意在她们网站放置你的网站链接的。

提供模板,插件等免费下载功能

绚丽实用的模板,功能齐全的插件也能满足用户特定需求,此类方式十分有效。以峰会程序Discuz为例,它们是不会为自己网站建设外链的,它们的外链都是用户自然为它们建设的,原因在于这个程序帮助了很多人,它们是善意的回报。

博客建设

博客内容质量的高低能决定其传播的范围,专心建设的博客能得到很多人的追捧,通过原创的,受众大的内容帮助到细分访客,外链也会自然降低。

为网站做外部链接的方式举不胜举,找到更高效的,是最终目的。

防止网站被复制文章,大部分站长都是如此做的

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2020-08-26 19:58

防止网站被复制文章,被采集,有很多方式,现在网上普遍使用比较多的有两种方式,今天小编撰这篇文章,就把我自己晓得的两种方式分享给你们,希望对你们有所帮助吧。

第一种方式:

很多zblog站长都是通过一些插件严禁人家转载,当你打开她们网站的时侯,想复制的时侯按住滑鼠一点反应也没有,你以为是键盘出问题了,实际上不是,而是人家放做了防复制转载的插件。当然,小编没有放这样的防复制插件,我认为没有必要,因为人家想采集,还是能采集到的,只是在采集上面人家可能要多花点时间采集,所以不必多此一举。

第二种方式:

除了避免他人复制之外,还有一种就是通过一些机构登记一下版权,比如【鲸版权】就是一个可以登记文章版权的机构,在这里登记了文章版权以后,就会起到威慑他人的作用,反正小编见到这类有版权的文章是不敢去采集的。大家可以去登记试试。

写在最后:

虽然小编不是太反对采集,不过话又说回去,现在抢劫采集的网站一大堆,网站权重都很高,如果你的网站权重低,那还是影响挺大的,因为百度压根都辨识不出那个是原创,一般收录早点的就会觉得原创。这可对好多新站有很大影响,如果你的站点权重低被他人高权重的采集了,那就惨了,因为百度收录人家的比你的早,会觉得他的是原创的。所以,作为新站来说,做下版权登记也何尝不可。最后希望这些采集的网站,在采集上面稍为改改标题,改改内容,不全部复制的话,那还是可以接受的,如果连标题和内容全部一样就复制,那就不好了。

1人0人打赏 查看全部

防止网站被复制文章,大部分站长都是如此做的

防止网站被复制文章,被采集,有很多方式,现在网上普遍使用比较多的有两种方式,今天小编撰这篇文章,就把我自己晓得的两种方式分享给你们,希望对你们有所帮助吧。

第一种方式:

很多zblog站长都是通过一些插件严禁人家转载,当你打开她们网站的时侯,想复制的时侯按住滑鼠一点反应也没有,你以为是键盘出问题了,实际上不是,而是人家放做了防复制转载的插件。当然,小编没有放这样的防复制插件,我认为没有必要,因为人家想采集,还是能采集到的,只是在采集上面人家可能要多花点时间采集,所以不必多此一举。

第二种方式:

除了避免他人复制之外,还有一种就是通过一些机构登记一下版权,比如【鲸版权】就是一个可以登记文章版权的机构,在这里登记了文章版权以后,就会起到威慑他人的作用,反正小编见到这类有版权的文章是不敢去采集的。大家可以去登记试试。

写在最后:

虽然小编不是太反对采集,不过话又说回去,现在抢劫采集的网站一大堆,网站权重都很高,如果你的网站权重低,那还是影响挺大的,因为百度压根都辨识不出那个是原创,一般收录早点的就会觉得原创。这可对好多新站有很大影响,如果你的站点权重低被他人高权重的采集了,那就惨了,因为百度收录人家的比你的早,会觉得他的是原创的。所以,作为新站来说,做下版权登记也何尝不可。最后希望这些采集的网站,在采集上面稍为改改标题,改改内容,不全部复制的话,那还是可以接受的,如果连标题和内容全部一样就复制,那就不好了。

1人0人打赏

seo优化方案怎样避免他人采集自己网站文章

采集交流 • 优采云 发表了文章 • 0 个评论 • 273 次浏览 • 2020-08-26 11:40

我们可以想像一下,自己悉心编辑的文章被同行复制了,他拿去给他的网站进行seo优化方案,最后排行还比你高,对自己来讲得不偿失。下面,我给你们推荐一些避免他人采集你网站新闻的方式:

1.水印图象

在图象中,添加了厚水印,并且必须将文章中词数控制在一定范围内。不要饱含图象,只需几行文字,这将造成极其糟糕的用户体验,搜索引擎也将获得低分,网站排名将升高。

2.向body标签添加属性

向body标签添加属性,可以在线搜索特定代码。此代码字符串的功能是取消右键单击,通过复制文章有效防止荒谬的右键和Ctrl + C。但这也不是完全避开的方式。

有些人会使用您网站的快照时间来搜集文章,但极少有人使用这些技巧。除非某人的SEO优化解决方案正在查看您的网站,否则您必须修改另一种方式以防止搜集。

3.发送链接

文章发布后,立即将链接发送到搜索引擎并使它来接受它。通常,如果这是第一次跟踪器抓取文章的链接,第二个人会觉得他在复制他的文章时有剽窃,并且他的排行不会很高。

如果我复制另一个人的文章并且排行低于你的,我们怎么应对?我们可以在网站管理员平台上举报。

4.要求原创保护

上述三种方式都不是有用的。您可以在网站站长平台上申请原创保护,但并非所有人都可以申请。这是我们应当注意的事情。

如何避免他人采集自己网站文章?只要你采用了以上的那些方式,基本都还能解决避免复制文章的问题。另外假如遇见他人复制你的文章,排名比你高,且你举报也没有用的情况,那么说明对方的seo优化方案比你的好得多。 查看全部

seo优化方案怎样避免他人采集自己网站文章

我们可以想像一下,自己悉心编辑的文章被同行复制了,他拿去给他的网站进行seo优化方案,最后排行还比你高,对自己来讲得不偿失。下面,我给你们推荐一些避免他人采集你网站新闻的方式:

1.水印图象

在图象中,添加了厚水印,并且必须将文章中词数控制在一定范围内。不要饱含图象,只需几行文字,这将造成极其糟糕的用户体验,搜索引擎也将获得低分,网站排名将升高。

2.向body标签添加属性

向body标签添加属性,可以在线搜索特定代码。此代码字符串的功能是取消右键单击,通过复制文章有效防止荒谬的右键和Ctrl + C。但这也不是完全避开的方式。

有些人会使用您网站的快照时间来搜集文章,但极少有人使用这些技巧。除非某人的SEO优化解决方案正在查看您的网站,否则您必须修改另一种方式以防止搜集。

3.发送链接

文章发布后,立即将链接发送到搜索引擎并使它来接受它。通常,如果这是第一次跟踪器抓取文章的链接,第二个人会觉得他在复制他的文章时有剽窃,并且他的排行不会很高。

如果我复制另一个人的文章并且排行低于你的,我们怎么应对?我们可以在网站管理员平台上举报。

4.要求原创保护

上述三种方式都不是有用的。您可以在网站站长平台上申请原创保护,但并非所有人都可以申请。这是我们应当注意的事情。

如何避免他人采集自己网站文章?只要你采用了以上的那些方式,基本都还能解决避免复制文章的问题。另外假如遇见他人复制你的文章,排名比你高,且你举报也没有用的情况,那么说明对方的seo优化方案比你的好得多。

【doc】动态链接库在数据采集系统中的一个应用

采集交流 • 优采云 发表了文章 • 0 个评论 • 270 次浏览 • 2020-08-25 13:24

动态链接库在数据采集系统中的一个应用2004 控制工程ControlEngineeringofChina Jan。2004 Vo1。11。No。1 文章编号:1671—7848(2004)01~008704 动态链接库在数据采集系统中的一个应用 (大连铁道学院软件学院,辽宁抚顺116028)摘要:在实时系统的检测和控制过程中,为了达到数据采集的实时性和准确性。采 用了编制动态链接库的方式,对数据采集卡进行读写操作。详细介绍了动态链接库 集卡进行读写操作。能够保证数据采集的实时性和准确性。被控系统才能达到控制要求。 关键词:动态链接库(DLL);ACL 一8112 数据采集卡;数据采集 中图分类号:TP273 文献标识码:A 引言实时系统的检测和控制都离不开数据采集系 统,保证数据采集系统的高效性是实现高质量的 监测和控制的一个首要前提。目前,随着高集成 度数据采集卡的性能价钱比不断提升,它在数据 采集系统中的应用越来越广泛。为了将数据采集 信号采集到控制器中,使用动态链接库是一种挺好的办法。动态链接库文件 (DII)是一种用途十分广泛的文件,例如在Win— dows 操作系统中,它饰演着重要的角色,无论是 WindowsNT 还是Windows95/98,它们大部分的 功能都是通过动态链接库提供的。

动态链接库可 以很方便地被不同的用户使用,编写动态链接库 的程序开发人员只须提供动态链接库的库文件和 个函数调用说明文件,其他的应用程序开发人员就可以很方便地调用动态链接库的库函数。这 为结构化编程提供了便捷,并且让应用程序的升 级愈发便利,从而降低了编程的工作量。 动态链接库动态链接库(DynamiclankLibrary,简称 DLI)是能否进行动态链接的一个或多个函数的 集合。应用程序和函数的链接形式有动态链接和 静态链接两种。当应用程序和函数静态链接时, 每一个应用程序必须从静态链接库中取得所有需 要调用函数的代码,并且把这种代码放到应用程 序的可执行代码中。而动态链接则不同,首先,应 用程序中并不需要收录函数的代码,它仅仅收录 了应用程序运行过程中所调用的DLI 函数的一 些最基本信息(例如DII 文件位置函数名等)。 其次,应用程序和函数的链接既可以在应用程序 编译时进行,也可以在应用程序运行时进行。 与静态链接相比,动态链接有以下优点: 减少应用程序的规格,从而节省了硬碟空 间。特别是当几个应用程序使用同一个动态链接 库时,节约出来的硬碟空间将是太可观的。多 个应用程序可以同时访问显存中的动态链接库的 单一映射,节约程序运行的显存空间。

有利于 不同的程序共享数据,资源。使用动态链接库, 用户可以将应用程序分拆成各个独立的模块,有 利于程序日后的升级。必要时,开发者只需直接 更新DII 而用不着对应用程序本身做任何改动 就可以对应用程序的功能和用户插口做较大改 善。有利于用户养成结构化编程的好习惯。 1)动态链接库的导入方法动态链接库中 的函数可以分为内部函数和导入函数两种,内部 函数仅仅供动态链接库中的函数使用,只有导入 函数能够被其他的程序所调用。动态链接库存在 种函数导入方法。在源代码中使用一declspec(dllexport)关键 字。在一个DEF 文件中使用EXPORTS 声明 函数。LINK 命令中用EXPORTS 声明函数。 其中,前两种方式得到了广泛的应用。 收稿日期:2002。09。04;收修初稿日期:2002—11—07 作者简介:赵慧敏(1977 一),女,黑龙江尚志人,助教,硕士,主要从事智能控制,计算机 控制等方面的教学与科研工作。 2)动态链接库的链接形式动态链接库和应用程序之间的链接有两种链接形式:隐式链接 和显式链接。 隐式链接隐式链接时,应用程序和由编 写动态链接库程序员提供的lib 文件链接。

当调 用该动态链接库的应用程序被载入显存时,系统 自动加载动态链接库。 隐式链接时,用户难以提示系统DII 所在的 位置,因此,DII 文件最好保存在Windows 操作 系统手动搜救的地方。即 a。Windows 的目录下。b。Windows 操作系统 中的系统目录(通常为\Windows\System)。c。 应用程序所在的路径。d。当前路径//可以在当 前路径运行应用程序。 显式链接显式链接是在应用程序运行过 程中进行的。显式链接时,应用程序必须以明晰 的句子来申明加载/解载DII 的过程。当应用程 序须要加载动态链接库函数时,必须通过 Win32API 的LoadIibrary()和GetProeAddress() 函数分别实现载入动态链接库和获得待调用的函 数表针。当使用DIL 的程序结束时,框架手动调 用FreeIibrary()函数从显存中卸载它。 3DLL 在ACL。8112HG 数据采集卡中的 应用 用动态链接库编制了上位机与ACI 一8112HG 数据采集卡的读写程序。ACI。8112HG 是一种高 性能,高速度,多功能的数据采集卡。它提供了 12 位的A/D,D/A,DIO(数据输入输出)和计时器 /计数器几种最常用的检测和控制功能。

ACI 8112HG的硬件电路主要是由模拟I/O 电路,数 电路,时序控制电路,接口电路等构成。本系统中主要用到模拟量输入输出电路。通过此 数据采集卡,采集控制系统输出的各类模拟讯号, 并把它们转换成计算机就能辨识的数字讯号,然 后输入计算机。并把经计算机估算后输出的控制 电压数字讯号转换成模拟讯号传递给控制系统。 使用VB 来开发界面及处理程序,使用VC++编 制动态链接库来实现对数据采集卡的操作。 1)用VB 和VC 混合编程如今越来越多的 人采用VB 和VC 混合编程,用VB 快速开发出漂 亮的界面以及外围处理程序,再用VC 编写底层 的各类操作,例如显存的操作,IO 端口的操作等。 VC 中还可以嵌入汇编语言进行更底层的操作。 般的做法是将VC程序编译成DLI,在VB 用Declare句子申明DII 中的函数。 这是因为,VB 的一个很大的优点是能迅速 有效地编制程序界面,VB 的快速程序开发环境 在界面设计中和程序开发中是太有效的。另外, 在现代社会中,程序必须随着外界变化而不断改 变,VB 就太适合于这类工作。 但是,VB 的一个很大的缺点就是它对硬件 的访问能力比较差,速度低。

而C++语言则可 以对硬件的数学地址进行直接访问,能进行位操 作,硬件控制能力强,速度很快。所以,常用C C++来编制的动态链接库被VB调用以优化速 度。这也是为何VB 也就能拿来编制DII,但 却不被使用的诱因。 2)DII 在ACI 一8112HG 中的应用在所建 立的直流调速系统中,数据采集卡肩负着采集3 路模拟输入量:转速给定,转速反馈,电流反馈和 输出1 路数字输出量:控制电流输出的任务。 DII 的具体实现过程如下: 在VC++中新建MFCAppWizard(DLI)工 程MylO,在源代码文件MylO。cpp 中添加下边3 个函数: intFARPASCALinport(unsignedshortport)l/输入 函数 voidFARPASCALoutport(unsignedshortport,int value)//输出函数 floatFARPASCALsample(unsignedshortbase,int num)//A/D 转换函数 程序的主要代码如下: intFARPASCALinport(unsignedshortport) //调用一outp(port。

value)函数,向端口port输出值value shorttemp;floatdata; BYTEchannel;//BYTE 定义字节型变量 期赵慧敏等:动态链接库在数据采集系统中的一个应用。89。switch(num) {case0: channel=16;//把二进制数00010000 传送给A/ 通道多路转换寄存器,选择推挽形式,并告之数据采集卡启动第0 路模拟通道。A/D 通道多路转换寄存器是一 个只写寄存器,它拿来控制A/D 通道转换。当通道数写入 寄存器,多路转换器打开一个新通道并等待转换。其中, CLn 为多路转换器通道数(":0-3);CS0,CS1 是进行差 动和推挽选择的讯号。 break; case1: channel:17;//选择通道1 break; case2: channel=18://选择通道2 break; case3: channel=19;//选择通道3 break; case4: channel=20://选择通道4 break; case5: channel=21//选择通道5 break; case6: channel=22;//选择通道6 break; case7: channd=23://选择通道7 break; //选择A/D转换的通道号及输入方法 mowbx,base addbx,10 mowdx,bx mowal,channel oUtdx,al //触发A/D 转换 movbx,base addbx,12 mowdx,bx moval。

1 OUtdx,al//base+12 为软件触发寄存器地址。为让 ACL 一8112 产生一个A/D 转换触发脉冲。必须向寄存器写 入一些数据,这时A/D 转换将被触发。本程序向寄存器写 //查询A/D转换是否结束 movbx,base addbx,5 movdx。bx aal:inal,dx andal,OxlO jnzaal//ALC-8112 对模拟输入通道有12 位分辨率, 转换完的数字数据将储存在A/D 数据寄存器里,A/D 据被送到两个8位寄存器中,低字节数据送到地址base+ 中。高字节数据送到地址base+5中。数据就绪位 (DRDY)用来分辨A/D 转换器的状态,当DRDY 位变为 低电平表明A/D 转换已完成。 转换结束,取数据movbx,base addbx,5 movdx,bx ina1。dx andal,0xf movbx,base addbx,4 rflovdx,bx ina1。dx rflovtemp,ax data=((float)temp/4096)*10;returndata; 模块定义文件MylO。def如下: LIBRARYMyI DESCRIPTION'MylOWindowsDynamicLinkLi— brary' EXPORTS; inport@1 outport@2 sample@3 在VB 中做一个模块,用来对所引用的动态 链接库函数进行声名。

如果MylO。dll 文件在 Windows 操作系统手动搜索的目录下,那么声名 格式如下: DeclareFunctioninportLib"MylO。dll"(ByValportAs Integer) DeclareFunctionoutportLib"MylO。du"(ByValport AsInteger。ByValValueAsInteger) DeclareFunctionsampleLib"MylO。dll"(ByValbaseAs Integer,ByValmumAsInteger) 结语本文首先介绍了动态链接库的编制方法,并 给出了动态链接库在直流调速系统的数据采集系 统中的一个应用在直流调速系统的运行过程 中,DII 保证了数据采集的实时性和准确性。在 事实上,动态链接库在许多方面都有重要的应用, 在程序的结构化设计中起到了非常重要的作用。 参考文献: 刘小石,郑淮,马林伟,等。精通VisualC++6。0[M]。北京:电子工业出版社,1999。 清源计算机工作室。VisualBasic6。0 开发宝典 [M]。北京:机械工业出版社,1999。 DavidJung。

PierreBoutquin。VB6 开发人员参考手 册[M]。北京:机械工业出版社,2000, ApplicationoftheDynamicLinkLibraryinDataAcquisitionSystems ZHAOHui—rain,LIWen,WANGXiao-ning,N 陋Bing,LIANGPei—peng (CollegeofSoftware。DalianRailwayInstitute。Dalian116028,China) Abstract:Inordertoassurethepropertiesofreal-timeandveracityofthedataacquisitioninthe processofmonitorandcontrol oftherea1。timesystem,thewayofdesigningprogramofthedynamiclinklibraryisusedtoread andwritethedataacquisition card。Firstly,thefunctionsandtheprocessofdesigningprogramsofthedynamiclinklibraryisi ntroduced。

Andthen,anappli— cationoflinngthedataacquisitionsystemwiththecontrollerbymeansofthedynamiclinklibr aryinthedirectcurrenttiming systemisgiven。Theactualresultofthedirectcurrenttimingsystemshowsthatitcanassurethe real—timeandtheveracityof thedataacqui~tionandthesystemcanattainthemanipulativeneedswithreadingandwritingt hedataacquisitioncardusedthe dynamiclinklibrary。 Keywords:dynamiclinklibrary:ACL-8112dataacquisitioncard;data采集 (上接第75 了200%多;用MMX技术优化时,由于Canny 子在模板运算后要进行求模操作,需要用C语言 实现,但速率也提升了400%多。

结语本文提出的两种对Canny 算子的过程进行 优化的方式适用于VC++6。0 或更高版的编译 平台,特别是第2 种方式只适用于支持MMX 术的处理器。由于Canny算子属于估算密集型 算法,处理的数据量大,基本上是对相邻的数据进 行操作,且通常是短小而高度重复的循环,因此适 合于MMX 编程。无论是更改现有的应用程序, 还是写一个新程序,都需考虑要加工的数据是否 -+--4---4-*+*+-+ 适合MMX 处理,如何优化程序结构以提升处理 效率等。实验结果表明,上述方式能较大地增强 Canny 算子的运算速率,对其他从事图象处理算 法优化的人员也具有一定的参考意义。 参考文献: 种有效方式一应用于半透明物体边沿检查[J]。天津轻工业学院,1998,13(2):55—59。 郑南宁。计算机视觉与模式识别[M]。北京:国防 工业出版社。1998。 "uDH。ShengLS。DSPchipanditsapplicationin image[J],Measurement&ControlTechnology, 2001。20(5):16—23。 [4]WuzY,RenYC,ZhangzY。

Multimediadataeffi— cientprocessingbasedonMMXtechnology[J]。Au— dioEngineering,1999,24(12):34—37。 DevelopmentandOptimizationofanIndustrialImageProcessing SoftwareBasedonEdgeDetection ZHANGCan。1ong,WANGQ,WENXiao-jun,ZHANGChao-ying,TANGYah。ping,LIUH ai-yan (1。CollegeofPhysicandInformationEngineering。GuangxiNormalUniversity,Guilin5410 04。China; 2。DeptofTeachingAffairs,GuilinUniversityofEelectronicTechnology,Guilin541004。Chi na) Abstract:AfastseparatealgorithmwithCannyoperatorusedforprocessingtheindustrialima gesisintroduced。

Twom~ures, compileroptimizationandMMXtechnologyoptimization。areadaptedinVC++6。0tofurthe roptimizethealgorithminorder todetecttheedgeofindustrialimagesquicklyandexactly,Theformerismainlyusedtocombin eselectionitemsofCcompiler, whilethelateradaptsMMXinstructionsandSIDM。Theresultsofexperimentshowthattheim provingalgorithmisfasterby 20096~4oO%thantheordinaryone。 Keywolds:Cannyoperator;compileroptimization;MMXtechnology 查看全部

【doc】动态链接库在数据采集系统中的一个应用

动态链接库在数据采集系统中的一个应用2004 控制工程ControlEngineeringofChina Jan。2004 Vo1。11。No。1 文章编号:1671—7848(2004)01~008704 动态链接库在数据采集系统中的一个应用 (大连铁道学院软件学院,辽宁抚顺116028)摘要:在实时系统的检测和控制过程中,为了达到数据采集的实时性和准确性。采 用了编制动态链接库的方式,对数据采集卡进行读写操作。详细介绍了动态链接库 集卡进行读写操作。能够保证数据采集的实时性和准确性。被控系统才能达到控制要求。 关键词:动态链接库(DLL);ACL 一8112 数据采集卡;数据采集 中图分类号:TP273 文献标识码:A 引言实时系统的检测和控制都离不开数据采集系 统,保证数据采集系统的高效性是实现高质量的 监测和控制的一个首要前提。目前,随着高集成 度数据采集卡的性能价钱比不断提升,它在数据 采集系统中的应用越来越广泛。为了将数据采集 信号采集到控制器中,使用动态链接库是一种挺好的办法。动态链接库文件 (DII)是一种用途十分广泛的文件,例如在Win— dows 操作系统中,它饰演着重要的角色,无论是 WindowsNT 还是Windows95/98,它们大部分的 功能都是通过动态链接库提供的。

动态链接库可 以很方便地被不同的用户使用,编写动态链接库 的程序开发人员只须提供动态链接库的库文件和 个函数调用说明文件,其他的应用程序开发人员就可以很方便地调用动态链接库的库函数。这 为结构化编程提供了便捷,并且让应用程序的升 级愈发便利,从而降低了编程的工作量。 动态链接库动态链接库(DynamiclankLibrary,简称 DLI)是能否进行动态链接的一个或多个函数的 集合。应用程序和函数的链接形式有动态链接和 静态链接两种。当应用程序和函数静态链接时, 每一个应用程序必须从静态链接库中取得所有需 要调用函数的代码,并且把这种代码放到应用程 序的可执行代码中。而动态链接则不同,首先,应 用程序中并不需要收录函数的代码,它仅仅收录 了应用程序运行过程中所调用的DLI 函数的一 些最基本信息(例如DII 文件位置函数名等)。 其次,应用程序和函数的链接既可以在应用程序 编译时进行,也可以在应用程序运行时进行。 与静态链接相比,动态链接有以下优点: 减少应用程序的规格,从而节省了硬碟空 间。特别是当几个应用程序使用同一个动态链接 库时,节约出来的硬碟空间将是太可观的。多 个应用程序可以同时访问显存中的动态链接库的 单一映射,节约程序运行的显存空间。

有利于 不同的程序共享数据,资源。使用动态链接库, 用户可以将应用程序分拆成各个独立的模块,有 利于程序日后的升级。必要时,开发者只需直接 更新DII 而用不着对应用程序本身做任何改动 就可以对应用程序的功能和用户插口做较大改 善。有利于用户养成结构化编程的好习惯。 1)动态链接库的导入方法动态链接库中 的函数可以分为内部函数和导入函数两种,内部 函数仅仅供动态链接库中的函数使用,只有导入 函数能够被其他的程序所调用。动态链接库存在 种函数导入方法。在源代码中使用一declspec(dllexport)关键 字。在一个DEF 文件中使用EXPORTS 声明 函数。LINK 命令中用EXPORTS 声明函数。 其中,前两种方式得到了广泛的应用。 收稿日期:2002。09。04;收修初稿日期:2002—11—07 作者简介:赵慧敏(1977 一),女,黑龙江尚志人,助教,硕士,主要从事智能控制,计算机 控制等方面的教学与科研工作。 2)动态链接库的链接形式动态链接库和应用程序之间的链接有两种链接形式:隐式链接 和显式链接。 隐式链接隐式链接时,应用程序和由编 写动态链接库程序员提供的lib 文件链接。

当调 用该动态链接库的应用程序被载入显存时,系统 自动加载动态链接库。 隐式链接时,用户难以提示系统DII 所在的 位置,因此,DII 文件最好保存在Windows 操作 系统手动搜救的地方。即 a。Windows 的目录下。b。Windows 操作系统 中的系统目录(通常为\Windows\System)。c。 应用程序所在的路径。d。当前路径//可以在当 前路径运行应用程序。 显式链接显式链接是在应用程序运行过 程中进行的。显式链接时,应用程序必须以明晰 的句子来申明加载/解载DII 的过程。当应用程 序须要加载动态链接库函数时,必须通过 Win32API 的LoadIibrary()和GetProeAddress() 函数分别实现载入动态链接库和获得待调用的函 数表针。当使用DIL 的程序结束时,框架手动调 用FreeIibrary()函数从显存中卸载它。 3DLL 在ACL。8112HG 数据采集卡中的 应用 用动态链接库编制了上位机与ACI 一8112HG 数据采集卡的读写程序。ACI。8112HG 是一种高 性能,高速度,多功能的数据采集卡。它提供了 12 位的A/D,D/A,DIO(数据输入输出)和计时器 /计数器几种最常用的检测和控制功能。

ACI 8112HG的硬件电路主要是由模拟I/O 电路,数 电路,时序控制电路,接口电路等构成。本系统中主要用到模拟量输入输出电路。通过此 数据采集卡,采集控制系统输出的各类模拟讯号, 并把它们转换成计算机就能辨识的数字讯号,然 后输入计算机。并把经计算机估算后输出的控制 电压数字讯号转换成模拟讯号传递给控制系统。 使用VB 来开发界面及处理程序,使用VC++编 制动态链接库来实现对数据采集卡的操作。 1)用VB 和VC 混合编程如今越来越多的 人采用VB 和VC 混合编程,用VB 快速开发出漂 亮的界面以及外围处理程序,再用VC 编写底层 的各类操作,例如显存的操作,IO 端口的操作等。 VC 中还可以嵌入汇编语言进行更底层的操作。 般的做法是将VC程序编译成DLI,在VB 用Declare句子申明DII 中的函数。 这是因为,VB 的一个很大的优点是能迅速 有效地编制程序界面,VB 的快速程序开发环境 在界面设计中和程序开发中是太有效的。另外, 在现代社会中,程序必须随着外界变化而不断改 变,VB 就太适合于这类工作。 但是,VB 的一个很大的缺点就是它对硬件 的访问能力比较差,速度低。

而C++语言则可 以对硬件的数学地址进行直接访问,能进行位操 作,硬件控制能力强,速度很快。所以,常用C C++来编制的动态链接库被VB调用以优化速 度。这也是为何VB 也就能拿来编制DII,但 却不被使用的诱因。 2)DII 在ACI 一8112HG 中的应用在所建 立的直流调速系统中,数据采集卡肩负着采集3 路模拟输入量:转速给定,转速反馈,电流反馈和 输出1 路数字输出量:控制电流输出的任务。 DII 的具体实现过程如下: 在VC++中新建MFCAppWizard(DLI)工 程MylO,在源代码文件MylO。cpp 中添加下边3 个函数: intFARPASCALinport(unsignedshortport)l/输入 函数 voidFARPASCALoutport(unsignedshortport,int value)//输出函数 floatFARPASCALsample(unsignedshortbase,int num)//A/D 转换函数 程序的主要代码如下: intFARPASCALinport(unsignedshortport) //调用一outp(port。

value)函数,向端口port输出值value shorttemp;floatdata; BYTEchannel;//BYTE 定义字节型变量 期赵慧敏等:动态链接库在数据采集系统中的一个应用。89。switch(num) {case0: channel=16;//把二进制数00010000 传送给A/ 通道多路转换寄存器,选择推挽形式,并告之数据采集卡启动第0 路模拟通道。A/D 通道多路转换寄存器是一 个只写寄存器,它拿来控制A/D 通道转换。当通道数写入 寄存器,多路转换器打开一个新通道并等待转换。其中, CLn 为多路转换器通道数(":0-3);CS0,CS1 是进行差 动和推挽选择的讯号。 break; case1: channel:17;//选择通道1 break; case2: channel=18://选择通道2 break; case3: channel=19;//选择通道3 break; case4: channel=20://选择通道4 break; case5: channel=21//选择通道5 break; case6: channel=22;//选择通道6 break; case7: channd=23://选择通道7 break; //选择A/D转换的通道号及输入方法 mowbx,base addbx,10 mowdx,bx mowal,channel oUtdx,al //触发A/D 转换 movbx,base addbx,12 mowdx,bx moval。

1 OUtdx,al//base+12 为软件触发寄存器地址。为让 ACL 一8112 产生一个A/D 转换触发脉冲。必须向寄存器写 入一些数据,这时A/D 转换将被触发。本程序向寄存器写 //查询A/D转换是否结束 movbx,base addbx,5 movdx。bx aal:inal,dx andal,OxlO jnzaal//ALC-8112 对模拟输入通道有12 位分辨率, 转换完的数字数据将储存在A/D 数据寄存器里,A/D 据被送到两个8位寄存器中,低字节数据送到地址base+ 中。高字节数据送到地址base+5中。数据就绪位 (DRDY)用来分辨A/D 转换器的状态,当DRDY 位变为 低电平表明A/D 转换已完成。 转换结束,取数据movbx,base addbx,5 movdx,bx ina1。dx andal,0xf movbx,base addbx,4 rflovdx,bx ina1。dx rflovtemp,ax data=((float)temp/4096)*10;returndata; 模块定义文件MylO。def如下: LIBRARYMyI DESCRIPTION'MylOWindowsDynamicLinkLi— brary' EXPORTS; inport@1 outport@2 sample@3 在VB 中做一个模块,用来对所引用的动态 链接库函数进行声名。

如果MylO。dll 文件在 Windows 操作系统手动搜索的目录下,那么声名 格式如下: DeclareFunctioninportLib"MylO。dll"(ByValportAs Integer) DeclareFunctionoutportLib"MylO。du"(ByValport AsInteger。ByValValueAsInteger) DeclareFunctionsampleLib"MylO。dll"(ByValbaseAs Integer,ByValmumAsInteger) 结语本文首先介绍了动态链接库的编制方法,并 给出了动态链接库在直流调速系统的数据采集系 统中的一个应用在直流调速系统的运行过程 中,DII 保证了数据采集的实时性和准确性。在 事实上,动态链接库在许多方面都有重要的应用, 在程序的结构化设计中起到了非常重要的作用。 参考文献: 刘小石,郑淮,马林伟,等。精通VisualC++6。0[M]。北京:电子工业出版社,1999。 清源计算机工作室。VisualBasic6。0 开发宝典 [M]。北京:机械工业出版社,1999。 DavidJung。

PierreBoutquin。VB6 开发人员参考手 册[M]。北京:机械工业出版社,2000, ApplicationoftheDynamicLinkLibraryinDataAcquisitionSystems ZHAOHui—rain,LIWen,WANGXiao-ning,N 陋Bing,LIANGPei—peng (CollegeofSoftware。DalianRailwayInstitute。Dalian116028,China) Abstract:Inordertoassurethepropertiesofreal-timeandveracityofthedataacquisitioninthe processofmonitorandcontrol oftherea1。timesystem,thewayofdesigningprogramofthedynamiclinklibraryisusedtoread andwritethedataacquisition card。Firstly,thefunctionsandtheprocessofdesigningprogramsofthedynamiclinklibraryisi ntroduced。

Andthen,anappli— cationoflinngthedataacquisitionsystemwiththecontrollerbymeansofthedynamiclinklibr aryinthedirectcurrenttiming systemisgiven。Theactualresultofthedirectcurrenttimingsystemshowsthatitcanassurethe real—timeandtheveracityof thedataacqui~tionandthesystemcanattainthemanipulativeneedswithreadingandwritingt hedataacquisitioncardusedthe dynamiclinklibrary。 Keywords:dynamiclinklibrary:ACL-8112dataacquisitioncard;data采集 (上接第75 了200%多;用MMX技术优化时,由于Canny 子在模板运算后要进行求模操作,需要用C语言 实现,但速率也提升了400%多。

结语本文提出的两种对Canny 算子的过程进行 优化的方式适用于VC++6。0 或更高版的编译 平台,特别是第2 种方式只适用于支持MMX 术的处理器。由于Canny算子属于估算密集型 算法,处理的数据量大,基本上是对相邻的数据进 行操作,且通常是短小而高度重复的循环,因此适 合于MMX 编程。无论是更改现有的应用程序, 还是写一个新程序,都需考虑要加工的数据是否 -+--4---4-*+*+-+ 适合MMX 处理,如何优化程序结构以提升处理 效率等。实验结果表明,上述方式能较大地增强 Canny 算子的运算速率,对其他从事图象处理算 法优化的人员也具有一定的参考意义。 参考文献: 种有效方式一应用于半透明物体边沿检查[J]。天津轻工业学院,1998,13(2):55—59。 郑南宁。计算机视觉与模式识别[M]。北京:国防 工业出版社。1998。 "uDH。ShengLS。DSPchipanditsapplicationin image[J],Measurement&ControlTechnology, 2001。20(5):16—23。 [4]WuzY,RenYC,ZhangzY。

Multimediadataeffi— cientprocessingbasedonMMXtechnology[J]。Au— dioEngineering,1999,24(12):34—37。 DevelopmentandOptimizationofanIndustrialImageProcessing SoftwareBasedonEdgeDetection ZHANGCan。1ong,WANGQ,WENXiao-jun,ZHANGChao-ying,TANGYah。ping,LIUH ai-yan (1。CollegeofPhysicandInformationEngineering。GuangxiNormalUniversity,Guilin5410 04。China; 2。DeptofTeachingAffairs,GuilinUniversityofEelectronicTechnology,Guilin541004。Chi na) Abstract:AfastseparatealgorithmwithCannyoperatorusedforprocessingtheindustrialima gesisintroduced。

Twom~ures, compileroptimizationandMMXtechnologyoptimization。areadaptedinVC++6。0tofurthe roptimizethealgorithminorder todetecttheedgeofindustrialimagesquicklyandexactly,Theformerismainlyusedtocombin eselectionitemsofCcompiler, whilethelateradaptsMMXinstructionsandSIDM。Theresultsofexperimentshowthattheim provingalgorithmisfasterby 20096~4oO%thantheordinaryone。 Keywolds:Cannyoperator;compileroptimization;MMXtechnology

影响网站排名的反向链接细节诱因盘点

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2020-08-23 08:49

短视频,自媒体,达人拔草一站服务

针对网站的某一个网页来说,所有来自其他页面指向自己的链接都叫“反向链接”,所以,某页面的反向链接包括站外链接和内部链接两部份。一般来说,反向链接数目越多,说明站点的价值越高,搜索引擎都会降低抓取频度,从而有助于网站的排行、流量的提高。

反向链接对seo的影响

那么,反向链接的什么细节诱因影响了网站排名。

1、链接网站的域名年纪,老域名的反向链接可能比新域名作用更大。

2、链接的域名数目或总量,在某种程度上说对排行会有所帮助,但是不是越多越好。

3、链接的广泛性、多样性,保证了链接的自然。比如C类IP地址,来自教育机构和政府网站的链接,后者被你们普遍觉得价值更大,而博客、论坛贴子一类的链接对微软排行影响不大,但对百度收录还是有作用的。

4、链接网站的域名权重、页面权重(PageRank),同等页面下,域名权重越高越好;通常情况下,首页的权重要低于内页。

5、链接的来源,垃圾网站的链接会损害网站排名,而来自竞争对手(关键词搜索结果中的其他网站)、垂直网站、行业权威网站的链接会比较有价值。

6、链接页面的内容相关、内容质量高(专业包且收录多媒体)会有较高的价值。

7、链接的位置,在内容开头的链接比内容结尾的链接权重高;页面主体内容中添加的链接比页面顶部或侧边栏中的链接权重更高;

8、来自301跳转的链接,能传递权重,但过多的301重定向链接会稀释部份PR。

9、锚文本,能发送强烈的相关讯号,而锚文本中出现关键词,会给与更多权重;链接附近相关文本有助于告诉Google你的页面主题,而“合作伙伴”、“赞助商链接”这样的词句可能会增加其附近链接的价值。

10、标签影响, Nofollow被搜索引擎用于分辨自然与非自然的链接,图像链接的Alt标签相当于图象的“锚文本”,而title标签也用作弱相关讯号。

11、其他细节诱因:

反向链接降低速率越快、添加时间越早,链接页面的字数越多,页面的出站链接数目越少,都有利于网站权重提高,而全站链接会被视为单个链接,而做PBN博客外链有疗效但同时具有风险。 查看全部

影响网站排名的反向链接细节诱因盘点

短视频,自媒体,达人拔草一站服务

针对网站的某一个网页来说,所有来自其他页面指向自己的链接都叫“反向链接”,所以,某页面的反向链接包括站外链接和内部链接两部份。一般来说,反向链接数目越多,说明站点的价值越高,搜索引擎都会降低抓取频度,从而有助于网站的排行、流量的提高。

反向链接对seo的影响

那么,反向链接的什么细节诱因影响了网站排名。

1、链接网站的域名年纪,老域名的反向链接可能比新域名作用更大。

2、链接的域名数目或总量,在某种程度上说对排行会有所帮助,但是不是越多越好。

3、链接的广泛性、多样性,保证了链接的自然。比如C类IP地址,来自教育机构和政府网站的链接,后者被你们普遍觉得价值更大,而博客、论坛贴子一类的链接对微软排行影响不大,但对百度收录还是有作用的。

4、链接网站的域名权重、页面权重(PageRank),同等页面下,域名权重越高越好;通常情况下,首页的权重要低于内页。

5、链接的来源,垃圾网站的链接会损害网站排名,而来自竞争对手(关键词搜索结果中的其他网站)、垂直网站、行业权威网站的链接会比较有价值。

6、链接页面的内容相关、内容质量高(专业包且收录多媒体)会有较高的价值。

7、链接的位置,在内容开头的链接比内容结尾的链接权重高;页面主体内容中添加的链接比页面顶部或侧边栏中的链接权重更高;

8、来自301跳转的链接,能传递权重,但过多的301重定向链接会稀释部份PR。

9、锚文本,能发送强烈的相关讯号,而锚文本中出现关键词,会给与更多权重;链接附近相关文本有助于告诉Google你的页面主题,而“合作伙伴”、“赞助商链接”这样的词句可能会增加其附近链接的价值。

10、标签影响, Nofollow被搜索引擎用于分辨自然与非自然的链接,图像链接的Alt标签相当于图象的“锚文本”,而title标签也用作弱相关讯号。

11、其他细节诱因:

反向链接降低速率越快、添加时间越早,链接页面的字数越多,页面的出站链接数目越少,都有利于网站权重提高,而全站链接会被视为单个链接,而做PBN博客外链有疗效但同时具有风险。

网络采集软件核心技术分析系列文章索引

采集交流 • 优采云 发表了文章 • 0 个评论 • 268 次浏览 • 2020-08-22 14:37

自己开发的豆约翰博客备份专家软件工具问世3年多以来,深受广大博客写作和阅读爱好者的喜爱。同时也不乏一些技术爱好者咨询我,这个软件上面各类实用的功能是怎样实现的。

为回馈社区,现将该软件中用到的核心技术,开辟一个专栏,写一个系列文章,以飨广大技术爱好者,希望你们多多支持。

系列文章提纲制定如下:

1.如何使用C#语言获取某个博主的全部博文链接及标题;

2.如何使用C#语言获得博文的内容;

3.使用C#语言怎样将html网页转换成pdf(html2pdf)

4.如何使用C#语言下载博文中的全部图片到本地并可以离线浏览

5.如何使用C#语言合成多个单个的pdf文件到一个pdf中,并生成目录

6.网易博客的链接怎样使用C#语言获取到,网易博客的特殊性;

7.微信公众号文章如何使用C#语言下载;

8.如何获取任意一篇文章的全部图文

9.如何使用C#语言除去html中的全部标签获取纯文本(html2txt)

10.怎样使用C#语言将多个html文件编译成chm(html2chm)

11.如何使用C#语言远程发布文章到新浪博客

12.如何使用C#语言开发静态站点生成器

13.怎样使用C#语言搭建程序框架(经典Winform界面,顶部菜单栏,工具栏,左边树状列表,右边多Tab界面)

14.如何使用C#语言实现网页编辑器(Winform)

...... 查看全部

网络采集软件核心技术分析系列文章索引

自己开发的豆约翰博客备份专家软件工具问世3年多以来,深受广大博客写作和阅读爱好者的喜爱。同时也不乏一些技术爱好者咨询我,这个软件上面各类实用的功能是怎样实现的。

为回馈社区,现将该软件中用到的核心技术,开辟一个专栏,写一个系列文章,以飨广大技术爱好者,希望你们多多支持。

系列文章提纲制定如下:

1.如何使用C#语言获取某个博主的全部博文链接及标题;

2.如何使用C#语言获得博文的内容;

3.使用C#语言怎样将html网页转换成pdf(html2pdf)

4.如何使用C#语言下载博文中的全部图片到本地并可以离线浏览

5.如何使用C#语言合成多个单个的pdf文件到一个pdf中,并生成目录

6.网易博客的链接怎样使用C#语言获取到,网易博客的特殊性;

7.微信公众号文章如何使用C#语言下载;

8.如何获取任意一篇文章的全部图文

9.如何使用C#语言除去html中的全部标签获取纯文本(html2txt)

10.怎样使用C#语言将多个html文件编译成chm(html2chm)

11.如何使用C#语言远程发布文章到新浪博客

12.如何使用C#语言开发静态站点生成器

13.怎样使用C#语言搭建程序框架(经典Winform界面,顶部菜单栏,工具栏,左边树状列表,右边多Tab界面)

14.如何使用C#语言实现网页编辑器(Winform)

......

网站编辑应当怎样写有质量的文章?

采集交流 • 优采云 发表了文章 • 0 个评论 • 254 次浏览 • 2020-08-22 10:47

文章的质量不高,只是为了保持网站的更新,相信大多数人是这样操作的,特别对于手头有几十上百个网站的人来说,根本没有那么多时间去写原创内容,大多内容是采集过来的,有时候甚至里面还带了原文的好多链接,而且很多人是写了些采集规则,每天手动采集内容的。这样做,我相信三天管理几百个站到上千个都没有问题,可是这样做,也给互联网制造了好多垃圾信息。

网站编辑应当怎样写有质量的文章?一、文章标题

Title:标题是一篇文章的主旨,是一个网页主题思想的高度概括,是要做到见标题而知意的,不能出现文不对题的情况。

填写标题需注意:

(1)收录要优化的“关键字”,标题必是文章的主题;

(2)如果有两个及以上的关键词出现在标题中,最重要的“核心关键字”尽量排前;

(3)文章标题不宜过长,不少于32个字。

(4)文章标题中可以适度重复,起注重指出的意思,但不能拼凑

文章标题不仅对排行很重要外,好的标题都会吸引网友眼珠,所以标题很重要,网站编辑一定要写好文章标题。

二、文章描述(description)

1、文章描述会出现在description标签中,对应于采编系统的“描述(key_description)”。

2、文章描述必须收录页面关键词,多个页面关键词要尽量全部在描述中出现。

3、文章描述尽可能的重复页面关键词,但不要刻意拼凑,一般重复三遍没有问题,重复关键词要有方法。

三、如何写原创文章

1、内容加减法:

在不影响文章原意的基础上,将文章加长或减短;在不影响语句本意的基础上,将诗句加长或减短,从而使内容显得与原先在较大改动。首尾原创,标题替换法;因为搜索引擎对于是否将一篇文章爬下去,第一段话是否是原创至关重要。因此伪原创的首段进行原创至关重要。而假如搜索引擎读到尾段发觉前面内容完全一样,也会对文章产生不信任,因此尾段完全原创也极其重要。

2、内容建立法(文笔不好也可以写高质量的文章):

找几篇同一个主题内容的优质文章,每篇文章里面提取一部分,针对不足之处,做建立补充,并重新组合成另一篇新的文章。这种方式,质量高,内容全,就像百度百科一样的作法。客户喜欢,搜索引擎也喜欢。【重点推荐】

3、完全原创法(适合文采较好的网站编辑):

文章完全原创,从0开始撰写,这样的文章对搜索引擎来说无疑是最好的,容易遭到搜索引擎的追捧,相比这些剽窃的文章,收录更快,排名也会更好。

四、内部链接规范

(1)增加在自己网站首页(次之栏目首页)显要位置的文字链入口――入口位置越靠前,维持时间越长,则对该链接页面搜索优化作用越大。

(2)一篇文章内,有关联的内容尽量互相链接上去,对访客和搜索引擎都有益处,访客容易找到相关内容,搜索引擎可以沿着链接仍然抓取,增加收录。

(3)尽量减低死链(不乱删掉文章,如果删掉文章,有链接到的地方,应该更正到现今的链接上来)

五、页面元素规范

1、文字

文章首段要尽可能出现页面关键词,最好很自然地出现与主题相关的词汇。页面关键词在文章正文中要有一定比列的分布,在不影响阅读的前提下,一些动词可以用页面关键词彰显。页面关键词在一篇文章的抒发方式要统一。

2、图片 查看全部

网站编辑应当怎样写有质量的文章?

文章的质量不高,只是为了保持网站的更新,相信大多数人是这样操作的,特别对于手头有几十上百个网站的人来说,根本没有那么多时间去写原创内容,大多内容是采集过来的,有时候甚至里面还带了原文的好多链接,而且很多人是写了些采集规则,每天手动采集内容的。这样做,我相信三天管理几百个站到上千个都没有问题,可是这样做,也给互联网制造了好多垃圾信息。

网站编辑应当怎样写有质量的文章?一、文章标题

Title:标题是一篇文章的主旨,是一个网页主题思想的高度概括,是要做到见标题而知意的,不能出现文不对题的情况。

填写标题需注意:

(1)收录要优化的“关键字”,标题必是文章的主题;

(2)如果有两个及以上的关键词出现在标题中,最重要的“核心关键字”尽量排前;

(3)文章标题不宜过长,不少于32个字。

(4)文章标题中可以适度重复,起注重指出的意思,但不能拼凑

文章标题不仅对排行很重要外,好的标题都会吸引网友眼珠,所以标题很重要,网站编辑一定要写好文章标题。

二、文章描述(description)

1、文章描述会出现在description标签中,对应于采编系统的“描述(key_description)”。

2、文章描述必须收录页面关键词,多个页面关键词要尽量全部在描述中出现。

3、文章描述尽可能的重复页面关键词,但不要刻意拼凑,一般重复三遍没有问题,重复关键词要有方法。

三、如何写原创文章

1、内容加减法:

在不影响文章原意的基础上,将文章加长或减短;在不影响语句本意的基础上,将诗句加长或减短,从而使内容显得与原先在较大改动。首尾原创,标题替换法;因为搜索引擎对于是否将一篇文章爬下去,第一段话是否是原创至关重要。因此伪原创的首段进行原创至关重要。而假如搜索引擎读到尾段发觉前面内容完全一样,也会对文章产生不信任,因此尾段完全原创也极其重要。

2、内容建立法(文笔不好也可以写高质量的文章):

找几篇同一个主题内容的优质文章,每篇文章里面提取一部分,针对不足之处,做建立补充,并重新组合成另一篇新的文章。这种方式,质量高,内容全,就像百度百科一样的作法。客户喜欢,搜索引擎也喜欢。【重点推荐】

3、完全原创法(适合文采较好的网站编辑):

文章完全原创,从0开始撰写,这样的文章对搜索引擎来说无疑是最好的,容易遭到搜索引擎的追捧,相比这些剽窃的文章,收录更快,排名也会更好。

四、内部链接规范

(1)增加在自己网站首页(次之栏目首页)显要位置的文字链入口――入口位置越靠前,维持时间越长,则对该链接页面搜索优化作用越大。