文章采集接口

文章采集接口权威网站上免费的网站爬虫爬数据接口

采集交流 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-08-28 02:02

文章采集接口权威网站上免费的文章采集接口给我,在接口网站的免费接口去采集他们的相关文章,

网站爬虫并不是一门网站开发方向的学科,题主如果想找一个能写爬虫爬数据的人,我想你可以让他自己去找本书去看看吧,爬虫这种东西其实是服务器端数据的接口对接的概念,不过建议题主还是去好好学习数据结构吧,程序语言只是一个工具,不要把太多时间浪费在这个上面。当然,题主你提到了经济上的问题,那么我想你应该已经发现了,人家如果只会做网站,可能也是做得不够专业的,一般的网站数据源来自于第三方数据接口,例如豆瓣读书数据来自于合作方,ua来自于第三方,这些都是通过第三方接口提供商提供的api。

如果题主你是想开发网站爬虫方向的程序猿,除了你说的以外,应该对常见的cookie,ua,referer,postmessage等都有所了解吧,也应该有很多相关的库吧,去找开源库然后自己封装一下,上线之前测试一下也是一个不错的选择。像豆瓣的接口方式基本上是可以很容易用python来实现的,除了稍微有点点库函数之外,就只需要一个selenium和phantomjs两个轮子就好了,但是如果想做的像豆瓣那么细致的话,可能还需要一点关于爬虫内核和常见数据结构的知识,像设计算法这种东西,我还没来得及深入研究。

所以我个人觉得,如果是想找一个做网站爬虫的人,那还是要自己比较细致的去和他交流,还有开源库的开发者也是可以的,一起共同完成网站爬虫的开发。 查看全部

文章采集接口权威网站上免费的网站爬虫爬数据接口

文章采集接口权威网站上免费的文章采集接口给我,在接口网站的免费接口去采集他们的相关文章,

网站爬虫并不是一门网站开发方向的学科,题主如果想找一个能写爬虫爬数据的人,我想你可以让他自己去找本书去看看吧,爬虫这种东西其实是服务器端数据的接口对接的概念,不过建议题主还是去好好学习数据结构吧,程序语言只是一个工具,不要把太多时间浪费在这个上面。当然,题主你提到了经济上的问题,那么我想你应该已经发现了,人家如果只会做网站,可能也是做得不够专业的,一般的网站数据源来自于第三方数据接口,例如豆瓣读书数据来自于合作方,ua来自于第三方,这些都是通过第三方接口提供商提供的api。

如果题主你是想开发网站爬虫方向的程序猿,除了你说的以外,应该对常见的cookie,ua,referer,postmessage等都有所了解吧,也应该有很多相关的库吧,去找开源库然后自己封装一下,上线之前测试一下也是一个不错的选择。像豆瓣的接口方式基本上是可以很容易用python来实现的,除了稍微有点点库函数之外,就只需要一个selenium和phantomjs两个轮子就好了,但是如果想做的像豆瓣那么细致的话,可能还需要一点关于爬虫内核和常见数据结构的知识,像设计算法这种东西,我还没来得及深入研究。

所以我个人觉得,如果是想找一个做网站爬虫的人,那还是要自己比较细致的去和他交流,还有开源库的开发者也是可以的,一起共同完成网站爬虫的开发。

文章采集接口啊,你的商品页面里面的都是扯淡

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2022-08-07 14:05

文章采集接口啊,你的商品页面里面只要有采集的数据,就可以把它采下来放在那个接口里面,之后你只要发布商品就能获取到返回的json数据了,都是一些数据文件啊。

btn.json->content.jsonctx.get->json

urllib相关文档1.pythonbuildthewebfromjavascriptcode优先级为52.urllib库的attributeerror处理3.ftp工具-python脚本开发。

楼上的都是扯淡,

我来两个国内比较出名的,酷站众测-python/电脑爬虫,普通版,量大。pypi.io-python/。国外,猪八戒网。

四个字

随便写一个爬虫程序,导出你需要的json,然后用numpy\pandas\scrapy这些数据分析库,把数据处理好放上去,或者用json.loads()把格式化好的数据写到flask的sina.json文件里。至于商品那个问题,你想怎么调怎么调。

最近才写了一个爬虫,天猫,也是做数据分析和爬虫的,

无图无真相。我是专门写爬虫的,所以json格式不了解,我提供一个思路给楼主。我们都知道python有requests库和scrapy爬虫框架,但是它们都有一个缺点,就是速度比较慢,得requests一千次,scrapy一万次。如果你确实想速度快,比如python3。那你请直接爬http,采集你要的数据,然后直接解析,json也好javajson也好。

当然json存储也是个问题,解析速度很慢的。python2直接这么干肯定是慢的,为什么,因为现有python框架都是支持字典的对象的,python3里则换成extensional,所以。不要在爬虫里用中的requests库(这个我不确定python3是不是不支持了)另外scrapy主要是用来做简单的爬虫,而且爬的时候尽量还是尽量减少数据库接触,目的是一定程度上避免很多字典对象的乱写,我们的目的是提高网站体验,也是为了提高数据的有效性,一定程度上加快刷新速度。

scrapy如果想使用其强大的requests库里的reqrequest模块,对象a和b是必须的。而且要注意检查日志记录。其它的什么flaskbottlebiovescrapyworking这些所有其它的框架都可以采用。如果这些在requestsscrapy下不如上面那些而花哨,请慎重对待。有时候后端会要求爬虫使用parse模块,你应该也不是为了爬虫而设计的。 查看全部

文章采集接口啊,你的商品页面里面的都是扯淡

文章采集接口啊,你的商品页面里面只要有采集的数据,就可以把它采下来放在那个接口里面,之后你只要发布商品就能获取到返回的json数据了,都是一些数据文件啊。

btn.json->content.jsonctx.get->json

urllib相关文档1.pythonbuildthewebfromjavascriptcode优先级为52.urllib库的attributeerror处理3.ftp工具-python脚本开发。

楼上的都是扯淡,

我来两个国内比较出名的,酷站众测-python/电脑爬虫,普通版,量大。pypi.io-python/。国外,猪八戒网。

四个字

随便写一个爬虫程序,导出你需要的json,然后用numpy\pandas\scrapy这些数据分析库,把数据处理好放上去,或者用json.loads()把格式化好的数据写到flask的sina.json文件里。至于商品那个问题,你想怎么调怎么调。

最近才写了一个爬虫,天猫,也是做数据分析和爬虫的,

无图无真相。我是专门写爬虫的,所以json格式不了解,我提供一个思路给楼主。我们都知道python有requests库和scrapy爬虫框架,但是它们都有一个缺点,就是速度比较慢,得requests一千次,scrapy一万次。如果你确实想速度快,比如python3。那你请直接爬http,采集你要的数据,然后直接解析,json也好javajson也好。

当然json存储也是个问题,解析速度很慢的。python2直接这么干肯定是慢的,为什么,因为现有python框架都是支持字典的对象的,python3里则换成extensional,所以。不要在爬虫里用中的requests库(这个我不确定python3是不是不支持了)另外scrapy主要是用来做简单的爬虫,而且爬的时候尽量还是尽量减少数据库接触,目的是一定程度上避免很多字典对象的乱写,我们的目的是提高网站体验,也是为了提高数据的有效性,一定程度上加快刷新速度。

scrapy如果想使用其强大的requests库里的reqrequest模块,对象a和b是必须的。而且要注意检查日志记录。其它的什么flaskbottlebiovescrapyworking这些所有其它的框架都可以采用。如果这些在requestsscrapy下不如上面那些而花哨,请慎重对待。有时候后端会要求爬虫使用parse模块,你应该也不是为了爬虫而设计的。

文章采集接口是你做运营对接对应的数据接口没什么

采集交流 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-07-31 00:00

文章采集接口是你做运营对接对应的数据接口,然后提交和获取数据,你无法直接的在你的服务器中直接获取数据,这是第一,然后它的网站还会有api的接口,第三就是接入api的服务器端也是由机房提供和api服务商对接的,这些资源是机房的话有的是需要收费的,不然没人做,第四就是第三方也有商业的api接口供参考,我做过的一个api大概是2万多吧,如果您有这方面的需求可以跟我联系,我了解一下。

这个需要说明下的,当然这个接口已经公开了,只要是靠谱的,对接不费力,只是需要付一点广告费,不过某宝上面随便找个价格都不会少于1200.建议淘宝当面对接,

可以和我合作,如果您不想开机器,我可以手把手教您使用,我们公司有很多年用外网做营销的经验,给您提供价值您2-5w不等的技术支持,可以试试。

好多渠道都有,都还比较便宜,对接一个好点的营销接口没什么,我一个营销软件接口就300-500,市场价格都不高。

如果网站支持外部链接,自己不动手也能弄个链接出来。推荐一个网站,我们公司只接电商类的站,一千多块钱,学校类的我也有接。

现在有很多软件平台都支持推广电商类外部链接,一千多块钱几十个外部链接接口并不贵,另外他也可以做活动之类的外部链接接入。一些传统网站也可以提供自己平台的外部链接接入。 查看全部

文章采集接口是你做运营对接对应的数据接口没什么

文章采集接口是你做运营对接对应的数据接口,然后提交和获取数据,你无法直接的在你的服务器中直接获取数据,这是第一,然后它的网站还会有api的接口,第三就是接入api的服务器端也是由机房提供和api服务商对接的,这些资源是机房的话有的是需要收费的,不然没人做,第四就是第三方也有商业的api接口供参考,我做过的一个api大概是2万多吧,如果您有这方面的需求可以跟我联系,我了解一下。

这个需要说明下的,当然这个接口已经公开了,只要是靠谱的,对接不费力,只是需要付一点广告费,不过某宝上面随便找个价格都不会少于1200.建议淘宝当面对接,

可以和我合作,如果您不想开机器,我可以手把手教您使用,我们公司有很多年用外网做营销的经验,给您提供价值您2-5w不等的技术支持,可以试试。

好多渠道都有,都还比较便宜,对接一个好点的营销接口没什么,我一个营销软件接口就300-500,市场价格都不高。

如果网站支持外部链接,自己不动手也能弄个链接出来。推荐一个网站,我们公司只接电商类的站,一千多块钱,学校类的我也有接。

现在有很多软件平台都支持推广电商类外部链接,一千多块钱几十个外部链接接口并不贵,另外他也可以做活动之类的外部链接接入。一些传统网站也可以提供自己平台的外部链接接入。

淘宝爬虫采集中小型卖家的商品详情页数据可视化分析

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2022-07-05 01:04

文章采集接口,并且需要文章和采集标题匹配,方法很多,有新浪微博爬虫,淘宝爬虫,采集中小型卖家的商品,一般来说,需要让我们的数据可视化分析商品详情页的数据变化,这是个比较麻烦的事,因为淘宝的产品详情页有百万字,每次都去登陆去查,估计就得php5.5及以上的程序,而且有个问题就是,有些网站可能是上一次销售时候留下的采集链接,那么很容易返回了账号和密码信息,而这个信息被淘宝后台盗用了,导致在淘宝后台上班,这是非常危险的,那么有没有比较便捷的办法呢?其实有很多,我这里用的是threejs+react开发,还可以自定义爬取结构,改变url和文章数量,处理返回链接安全性啥的,实现之后,github链接:,我们来一起搞起来,如下图所示,我们需要获取的是采集该商品在该商品详情页的购买信息,因为商品的信息要填的字段实在太多,直接去百度的txt文档的话,怕看不全,所以采用的是对应的react代码实现。

按照代码总共分为三步,首先是读取淘宝中小型卖家商品详情页的链接信息(直接下载源码就可以看到,把这个代码,或者引用的excel文件拷贝到浏览器中就可以读取),然后是读取react的代码,再来读取淘宝中小型卖家商品详情页的内容,最后就是写一个采集器,把这个爬取的商品详情页的数据,全部整理为excel表格(可以根据实际需要调整格式)。

先来看下代码:这里要注意,如果数据量比较大,像上图采集不下那么多条数据,基本上就用不了代码,可以用utils文件直接读取数据,获取的过程需要设置字段名,获取的数据也很简单,就是string类型,我设置了他们的元素样式。因为数据比较多,我就保存在了axios中,方便以后自动处理。而关于爬取逻辑,基本就是根据我们接口查询该商品的历史销售数据来做信息筛选,而接口数据是在淘宝api中获取的,那么我们就可以根据淘宝api获取的历史购买数据,获取淘宝中小型卖家的历史销售信息,以及数据的差异变化来匹配信息,我就拿出以前写过的代码用threejs开发。

具体代码可以直接去github下载,axios中使用代码整理的api链接,如下:,其实现的这个爬取淘宝中小型卖家商品详情页详情页信息的代码,和那个淘宝店铺商品数据筛选的差不多,区别是我们除了针对中小型卖家,还做了扩展出来,方便我们以后数据的下载或者分析。然后我们采用我刚才写的代码,循环爬取中小型卖家商品信息,每个商品就获取10个数据,然后来分析数据页和dom的变化关系,获取全部数据后,通过时间来筛选最终dom中的内容即可,这样,无论最终是否下载这个数据,都是可以。 查看全部

淘宝爬虫采集中小型卖家的商品详情页数据可视化分析

文章采集接口,并且需要文章和采集标题匹配,方法很多,有新浪微博爬虫,淘宝爬虫,采集中小型卖家的商品,一般来说,需要让我们的数据可视化分析商品详情页的数据变化,这是个比较麻烦的事,因为淘宝的产品详情页有百万字,每次都去登陆去查,估计就得php5.5及以上的程序,而且有个问题就是,有些网站可能是上一次销售时候留下的采集链接,那么很容易返回了账号和密码信息,而这个信息被淘宝后台盗用了,导致在淘宝后台上班,这是非常危险的,那么有没有比较便捷的办法呢?其实有很多,我这里用的是threejs+react开发,还可以自定义爬取结构,改变url和文章数量,处理返回链接安全性啥的,实现之后,github链接:,我们来一起搞起来,如下图所示,我们需要获取的是采集该商品在该商品详情页的购买信息,因为商品的信息要填的字段实在太多,直接去百度的txt文档的话,怕看不全,所以采用的是对应的react代码实现。

按照代码总共分为三步,首先是读取淘宝中小型卖家商品详情页的链接信息(直接下载源码就可以看到,把这个代码,或者引用的excel文件拷贝到浏览器中就可以读取),然后是读取react的代码,再来读取淘宝中小型卖家商品详情页的内容,最后就是写一个采集器,把这个爬取的商品详情页的数据,全部整理为excel表格(可以根据实际需要调整格式)。

先来看下代码:这里要注意,如果数据量比较大,像上图采集不下那么多条数据,基本上就用不了代码,可以用utils文件直接读取数据,获取的过程需要设置字段名,获取的数据也很简单,就是string类型,我设置了他们的元素样式。因为数据比较多,我就保存在了axios中,方便以后自动处理。而关于爬取逻辑,基本就是根据我们接口查询该商品的历史销售数据来做信息筛选,而接口数据是在淘宝api中获取的,那么我们就可以根据淘宝api获取的历史购买数据,获取淘宝中小型卖家的历史销售信息,以及数据的差异变化来匹配信息,我就拿出以前写过的代码用threejs开发。

具体代码可以直接去github下载,axios中使用代码整理的api链接,如下:,其实现的这个爬取淘宝中小型卖家商品详情页详情页信息的代码,和那个淘宝店铺商品数据筛选的差不多,区别是我们除了针对中小型卖家,还做了扩展出来,方便我们以后数据的下载或者分析。然后我们采用我刚才写的代码,循环爬取中小型卖家商品信息,每个商品就获取10个数据,然后来分析数据页和dom的变化关系,获取全部数据后,通过时间来筛选最终dom中的内容即可,这样,无论最终是否下载这个数据,都是可以。

简历写着熟悉 Dubbo,居然连 Dubbo 线程池监控都不知道?

采集交流 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-07-03 23:26

Dubbo 是一款优秀的微服务框架,它以其高性能、简单易用、易扩展等特点,广泛应用于互联网、金融保险、科技公司、制造业、零售物流等多个领域。如今,Dubbo 框架已经成了互联网开发中比较常用的技术框架。

在Dubbo框架中,当客户端调用服务端的时候,请求抵达了服务端之后,会有专门的线程池去接收参数并且处理。所以如果要实现Dubbo的线程池监控,就需要先了解下Dubbo底层对于业务线程池的实现原理。

Dubbo底层对于线程池的查看

这里我所使用的框架是 Dubbo 2.7.8 版本,它在底层对于线程池的管理是通过一个叫做ExecutorRepository 的类处理的,这个类负责创建并管理 Dubbo 中的线程池,通过该扩展接口,我们可以获取到Dubbo再实际运行中的业务线程池对象。

具体的处理逻辑部分如下所示:

package org.idea.dubbo.monitor.core.collect;<br />import org.apache.dubbo.common.extension.ExtensionLoader;<br />import org.apache.dubbo.common.threadpool.manager.DefaultExecutorRepository;<br />import org.apache.dubbo.common.threadpool.manager.ExecutorRepository;<br />import java.lang.reflect.Field;<br />import java.util.concurrent.ConcurrentMap;<br />import java.util.concurrent.ExecutorService;<br />import java.util.concurrent.ThreadPoolExecutor;<br />/**<br /> * @Author idea<br /> * @Date created in 7:04 下午 2022/6/29<br /> */<br />public class DubboThreadPoolCollector {<br /> /**<br /> * 获取Dubbo的线程池<br /> * @return<br /> */<br /> public static ThreadPoolExecutor getDubboThreadPoolInfo(){<br /> //dubbo线程池数量监控<br /> try {<br /> ExtensionLoader executorRepositoryExtensionLoader = ExtensionLoader.getExtensionLoader(ExecutorRepository.class);<br /> DefaultExecutorRepository defaultExecutorRepository = (DefaultExecutorRepository) executorRepositoryExtensionLoader.getDefaultExtension();<br /> Field dataField = defaultExecutorRepository.getClass().getDeclaredField("data");<br /> dataField.setAccessible(true);<br /> ConcurrentMap data = (ConcurrentMap) dataField.get(defaultExecutorRepository);<br /> ConcurrentMap executorServiceConcurrentMap = data.get("java.util.concurrent.ExecutorService");<br /> //获取到默认的线程池模型<br /> ThreadPoolExecutor threadPoolExecutor = (ThreadPoolExecutor) executorServiceConcurrentMap.get(9090);<br /> return threadPoolExecutor;<br /> } catch (Exception e) {<br /> e.printStackTrace();<br /> }<br /> return null;<br /> }<br />}

好了,现在我们知道如何在代码中实时查看Dubbo线程池的信息了,那么接下来要做的就是如何采集这些线程池的数据,并且进行上报,最后将上报存储的数据通过统计图的方式展示出来。

下边我们按照采集,上报,展示三个环节来展示数据。

采集数据

在采集数据这块,有两种思路去采集,分别如下:

采用两种不同的模式采集出来的数据,可能会有些差异,下边是两种方式的比对:

统计方式实现难度可能存在的问题

定时任务采集数据

简单

定时任务执行间隙中的数据无法采集,导致数据失真。

请求抵达是采集数据

稍为复杂一些

在每次请求的时候都需要采集数据,会对性能有一定损耗。

通过对实际的业务场景分析,其实第二种方式对应用的性能损耗极微,甚至可以忽略,所以使用这种方式去采集数据的话会比较合适。

下边让我们一起来看看这种方式采集数据的话,该如何实现。

首先我们需要自己定义一个filter过滤器:

package org.idea.dubbo.monitor.core.filter;<br />import org.apache.dubbo.common.constants.CommonConstants;<br />import org.apache.dubbo.common.extension.Activate;<br />import org.apache.dubbo.rpc.*;<br />import org.idea.dubbo.monitor.core.DubboMonitorHandler;<br />import java.util.concurrent.ThreadPoolExecutor;<br />import static org.idea.dubbo.monitor.core.config.CommonCache.DUBBO_INFO_STORE_CENTER;<br />/**<br /> * @Author idea<br /> * @Date created in 2:33 下午 2022/7/1<br /> */<br />@Activate(group = CommonConstants.PROVIDER)<br />public class DubboRecordFilter implements Filter {<br /> @Override<br /> public Result invoke(Invoker invoker, Invocation invocation) throws RpcException {<br /> ThreadPoolExecutor threadPoolExecutor = DubboMonitorHandler.getDubboThreadPoolInfo();<br /> //请求的时候趣统计线程池,当请求量太小的时候,这块的数据可能不准确,但是如果请求量大的话,就接近准确了<br /> DUBBO_INFO_STORE_CENTER.reportInfo(9090,threadPoolExecutor.getActiveCount(),threadPoolExecutor.getQueue().size());<br /> return invoker.invoke(invocation);<br /> }<br />}<br />

关于DUBBO_INFO_STORE_CENTER的代码如下所示:

并且在dubbo的spi配置文件中指定好它们:

dubboRecordFilter=org.idea.dubbo.monitor.core.filter.DubboRecordFilter<br />

当provider加入了这个过滤器以后,若有请求抵达服务端,则会通过这个filter触发采集操作。

package org.idea.dubbo.monitor.core.collect;<br />import org.idea.dubbo.monitor.core.bo.DubboInfoStoreBO;<br />import java.util.Map;<br />import java.util.concurrent.ConcurrentHashMap;<br />/**<br /> * Dubbo数据存储中心<br /> *<br /> * @Author idea<br /> * @Date created in 11:15 上午 2022/7/1<br /> */<br />public class DubboInfoStoreCenter {<br /> private static Map dubboInfoStoreBOMap = new ConcurrentHashMap();<br /> public void reportInfo(Integer port, Integer corePoolSize, Integer queueLength) {<br /> synchronized (this) {<br /> DubboInfoStoreBO dubboInfoStoreBO = dubboInfoStoreBOMap.get(port);<br /> if (dubboInfoStoreBO != null) {<br /> boolean hasChange = false;<br /> int currentMaxPoolSize = dubboInfoStoreBO.getMaxCorePoolSize();<br /> int currentMaxQueueLength = dubboInfoStoreBO.getMaxCorePoolSize();<br /> if (corePoolSize > currentMaxPoolSize) {<br /> dubboInfoStoreBO.setMaxCorePoolSize(corePoolSize);<br /> hasChange = true;<br /> }<br /> if (queueLength > currentMaxQueueLength) {<br /> dubboInfoStoreBO.setMaxQueueLength(queueLength);<br /> hasChange = true;<br /> }<br /> if (hasChange) {<br /> dubboInfoStoreBOMap.put(port, dubboInfoStoreBO);<br /> }<br /> } else {<br /> dubboInfoStoreBO = new DubboInfoStoreBO();<br /> dubboInfoStoreBO.setMaxQueueLength(queueLength);<br /> dubboInfoStoreBO.setMaxCorePoolSize(corePoolSize);<br /> dubboInfoStoreBOMap.put(port, dubboInfoStoreBO);<br /> }<br /> }<br /> }<br /> public DubboInfoStoreBO getInfo(Integer port){<br /> return dubboInfoStoreBOMap.get(port);<br /> }<br /> public void cleanInfo(Integer port) {<br /> dubboInfoStoreBOMap.remove(port);<br /> }<br />}<br />

注意这个采集类只会采集一段时间的数据,然后定期会清空重置。

之所以这么做,是希望用这个map统计指定时间内的最大线程数和最大队列数,接着当这些峰值数据被上报到存储中心后就进行清空。

关于DubboInfoStoreCenter对象的定义,我将它放置在了一个叫做CommonCache的类里面,具体如下:

package org.idea.dubbo.monitor.core.config;<br />import org.idea.dubbo.monitor.core.store.DubboInfoStoreCenter;<br />/**<br /> * @Author idea<br /> * @Date created in 12:15 下午 2022/7/1<br /> */<br />public class CommonCache {<br /> public static DubboInfoStoreCenter DUBBO_INFO_STORE_CENTER = new DubboInfoStoreCenter();<br />}<br />

所以在上边的过滤器中,我们才可以直接通过静态类引用去调用它的采集接口。

好了,现在整体来看,我们已经实现了在过滤器中去实时采集线程池的数据,并且将它暂存在了一个Map表中,这个map的数据主要是记录了某段时间内的线程池峰值,供采集器角色去使用。

那么接下来,我们就来看看上报器模块主要做了哪些操作。

上报数据

上报数据前,最重要的就是选择合适的存储组件了。首先上报的数据本身体量并不大,我们可以将采集时间短设置为15秒,那么设计一个上报任务,每隔15秒采集一次dubbo线程池的数据。那么一天的时间就需上报5760次,假设一次上报存储一条记录的话,那么一天下来所需要存储的数据也并不是特别多。

并且存储下来的服务数据实际上也并不需要保留太长的时间,一般存储个一周时间也就足够了,所以最终我选用啦Redis进行这方面的存储。

我们实际每次关注的数据字段主要有三个,关于它们的定义我整理成了下边这个对象:

package org.idea.dubbo.monitor.core.bo;<br />/**<br /> * @Author idea<br /> * @Date created in 7:17 下午 2022/6/29<br /> */<br />public class ThreadInfoBO {<br /><br /><br /> private Integer activePoolSize;<br /> private Integer queueLength;<br /> private long saveTime;<br /> public Integer getActivePoolSize() {<br /> return activePoolSize;<br /> }<br /> public void setActivePoolSize(Integer activePoolSize) {<br /> this.activePoolSize = activePoolSize;<br /> }<br /> public Integer getQueueLength() {<br /> return queueLength;<br /> }<br /> public void setQueueLength(Integer queueLength) {<br /> this.queueLength = queueLength;<br /> }<br /> public long getSaveTime() {<br /> return saveTime;<br /> }<br /> public void setSaveTime(long saveTime) {<br /> this.saveTime = saveTime;<br /> }<br /> @Override<br /> public String toString() {<br /> return "ThreadInfoBO{" +<br /> ", queueLength=" + queueLength +<br /> ", saveTime=" + saveTime +<br /> '}';<br /> }<br />}<br />

接着会开启一个线程任务,每间隔15秒就会执行一轮上报数据的动作:

这类要注意下,Dubbo应用的线程池上报任务应当等整个SpringBoot应用启动成功之后再去触发,否则可能会有些许数据不准确性。所以再定义Bean初始化线程的时候,我选择了CommandLineRunner接口。

细心查看代码的你可能会看到这么一个类:

org.idea.dubbo.monitor.core.report.IReportTemplate<br />

这个类定义了数据上报器的基本动作,下边是它的具体代码:

package org.idea.dubbo.monitor.core.report;<br /><br /><br />/**<br /> * 上报模版<br /> *<br /> * @Author idea<br /> * @Date created in 7:10 下午 2022/6/29<br /> */<br />public interface IReportTemplate {<br /> /**<br /> * 上报数据<br /> *<br /> * @return<br /> */<br /> boolean reportData(String json);<br /><br /><br />}<br />

实现类部分如下所示:

package org.idea.dubbo.monitor.core.report.impl;<br />import org.idea.dubbo.monitor.core.report.IReportTemplate;<br />import org.idea.qiyu.cache.redis.service.IRedisService;<br />import org.springframework.stereotype.Component;<br />import javax.annotation.Resource;<br />import java.time.LocalDate;<br />import java.util.concurrent.TimeUnit;<br />/**<br /> * @Author idea<br /> * @Date created in 7:12 下午 2022/6/29<br /> */<br />@Component<br />public class RedisTemplateImpl implements IReportTemplate {<br /> @Resource<br /> private IRedisService redisService;<br /> private static String queueKey = "dubbo:threadpool:info:";<br /> @Override<br /> public boolean reportData(String json) {<br /> redisService.lpush(queueKey + LocalDate.now().toString(), json);<br /> redisService.expire(queueKey + LocalDate.now().toString(),7, TimeUnit.DAYS);<br /> return true;<br /> }<br /><br /><br />}<br />

这里面我采用的是list的结构去存储这些数据指标,设定了一个过期时间为一周,最终存储到redis之后的格式如下所示:

数据展示

好了,现在我们已经完成了对线程池的监控,最后只需要设计一个管理台,从缓存中提取上报的数据并且进行页面的展示即可。

实现的逻辑比较简单,只需要定义好统计图所需要的数据结构,然后在controller曾返回即可,例如下图所示:

最终展现出来的效果如下图:

随着请求dubbo接口的量发生变化,统计图可以展示出dubbo线程池的数据变动情况。如果希望统计图以实时的方式展示数据的话,其实只需要在js中写一个定时调用的函数即可。

这里我是使用的是echart插件做的图表渲染,我选用的是最简单的统计图类型,大家也可以根据自己的具体所需在echart的官网上选择合适的模型进行渲染,下边这是echart的官网地址:

推荐

PS:因为公众号平台更改了推送规则,如果不想错过内容,记得读完点一下“在看”,加个“星标”,这样每次新文章推送才会第一时间出现在你的订阅列表里。点“在看”支持我们吧! 查看全部

简历写着熟悉 Dubbo,居然连 Dubbo 线程池监控都不知道?

Dubbo 是一款优秀的微服务框架,它以其高性能、简单易用、易扩展等特点,广泛应用于互联网、金融保险、科技公司、制造业、零售物流等多个领域。如今,Dubbo 框架已经成了互联网开发中比较常用的技术框架。

在Dubbo框架中,当客户端调用服务端的时候,请求抵达了服务端之后,会有专门的线程池去接收参数并且处理。所以如果要实现Dubbo的线程池监控,就需要先了解下Dubbo底层对于业务线程池的实现原理。

Dubbo底层对于线程池的查看

这里我所使用的框架是 Dubbo 2.7.8 版本,它在底层对于线程池的管理是通过一个叫做ExecutorRepository 的类处理的,这个类负责创建并管理 Dubbo 中的线程池,通过该扩展接口,我们可以获取到Dubbo再实际运行中的业务线程池对象。

具体的处理逻辑部分如下所示:

package org.idea.dubbo.monitor.core.collect;<br />import org.apache.dubbo.common.extension.ExtensionLoader;<br />import org.apache.dubbo.common.threadpool.manager.DefaultExecutorRepository;<br />import org.apache.dubbo.common.threadpool.manager.ExecutorRepository;<br />import java.lang.reflect.Field;<br />import java.util.concurrent.ConcurrentMap;<br />import java.util.concurrent.ExecutorService;<br />import java.util.concurrent.ThreadPoolExecutor;<br />/**<br /> * @Author idea<br /> * @Date created in 7:04 下午 2022/6/29<br /> */<br />public class DubboThreadPoolCollector {<br /> /**<br /> * 获取Dubbo的线程池<br /> * @return<br /> */<br /> public static ThreadPoolExecutor getDubboThreadPoolInfo(){<br /> //dubbo线程池数量监控<br /> try {<br /> ExtensionLoader executorRepositoryExtensionLoader = ExtensionLoader.getExtensionLoader(ExecutorRepository.class);<br /> DefaultExecutorRepository defaultExecutorRepository = (DefaultExecutorRepository) executorRepositoryExtensionLoader.getDefaultExtension();<br /> Field dataField = defaultExecutorRepository.getClass().getDeclaredField("data");<br /> dataField.setAccessible(true);<br /> ConcurrentMap data = (ConcurrentMap) dataField.get(defaultExecutorRepository);<br /> ConcurrentMap executorServiceConcurrentMap = data.get("java.util.concurrent.ExecutorService");<br /> //获取到默认的线程池模型<br /> ThreadPoolExecutor threadPoolExecutor = (ThreadPoolExecutor) executorServiceConcurrentMap.get(9090);<br /> return threadPoolExecutor;<br /> } catch (Exception e) {<br /> e.printStackTrace();<br /> }<br /> return null;<br /> }<br />}

好了,现在我们知道如何在代码中实时查看Dubbo线程池的信息了,那么接下来要做的就是如何采集这些线程池的数据,并且进行上报,最后将上报存储的数据通过统计图的方式展示出来。

下边我们按照采集,上报,展示三个环节来展示数据。

采集数据

在采集数据这块,有两种思路去采集,分别如下:

采用两种不同的模式采集出来的数据,可能会有些差异,下边是两种方式的比对:

统计方式实现难度可能存在的问题

定时任务采集数据

简单

定时任务执行间隙中的数据无法采集,导致数据失真。

请求抵达是采集数据

稍为复杂一些

在每次请求的时候都需要采集数据,会对性能有一定损耗。

通过对实际的业务场景分析,其实第二种方式对应用的性能损耗极微,甚至可以忽略,所以使用这种方式去采集数据的话会比较合适。

下边让我们一起来看看这种方式采集数据的话,该如何实现。

首先我们需要自己定义一个filter过滤器:

package org.idea.dubbo.monitor.core.filter;<br />import org.apache.dubbo.common.constants.CommonConstants;<br />import org.apache.dubbo.common.extension.Activate;<br />import org.apache.dubbo.rpc.*;<br />import org.idea.dubbo.monitor.core.DubboMonitorHandler;<br />import java.util.concurrent.ThreadPoolExecutor;<br />import static org.idea.dubbo.monitor.core.config.CommonCache.DUBBO_INFO_STORE_CENTER;<br />/**<br /> * @Author idea<br /> * @Date created in 2:33 下午 2022/7/1<br /> */<br />@Activate(group = CommonConstants.PROVIDER)<br />public class DubboRecordFilter implements Filter {<br /> @Override<br /> public Result invoke(Invoker invoker, Invocation invocation) throws RpcException {<br /> ThreadPoolExecutor threadPoolExecutor = DubboMonitorHandler.getDubboThreadPoolInfo();<br /> //请求的时候趣统计线程池,当请求量太小的时候,这块的数据可能不准确,但是如果请求量大的话,就接近准确了<br /> DUBBO_INFO_STORE_CENTER.reportInfo(9090,threadPoolExecutor.getActiveCount(),threadPoolExecutor.getQueue().size());<br /> return invoker.invoke(invocation);<br /> }<br />}<br />

关于DUBBO_INFO_STORE_CENTER的代码如下所示:

并且在dubbo的spi配置文件中指定好它们:

dubboRecordFilter=org.idea.dubbo.monitor.core.filter.DubboRecordFilter<br />

当provider加入了这个过滤器以后,若有请求抵达服务端,则会通过这个filter触发采集操作。

package org.idea.dubbo.monitor.core.collect;<br />import org.idea.dubbo.monitor.core.bo.DubboInfoStoreBO;<br />import java.util.Map;<br />import java.util.concurrent.ConcurrentHashMap;<br />/**<br /> * Dubbo数据存储中心<br /> *<br /> * @Author idea<br /> * @Date created in 11:15 上午 2022/7/1<br /> */<br />public class DubboInfoStoreCenter {<br /> private static Map dubboInfoStoreBOMap = new ConcurrentHashMap();<br /> public void reportInfo(Integer port, Integer corePoolSize, Integer queueLength) {<br /> synchronized (this) {<br /> DubboInfoStoreBO dubboInfoStoreBO = dubboInfoStoreBOMap.get(port);<br /> if (dubboInfoStoreBO != null) {<br /> boolean hasChange = false;<br /> int currentMaxPoolSize = dubboInfoStoreBO.getMaxCorePoolSize();<br /> int currentMaxQueueLength = dubboInfoStoreBO.getMaxCorePoolSize();<br /> if (corePoolSize > currentMaxPoolSize) {<br /> dubboInfoStoreBO.setMaxCorePoolSize(corePoolSize);<br /> hasChange = true;<br /> }<br /> if (queueLength > currentMaxQueueLength) {<br /> dubboInfoStoreBO.setMaxQueueLength(queueLength);<br /> hasChange = true;<br /> }<br /> if (hasChange) {<br /> dubboInfoStoreBOMap.put(port, dubboInfoStoreBO);<br /> }<br /> } else {<br /> dubboInfoStoreBO = new DubboInfoStoreBO();<br /> dubboInfoStoreBO.setMaxQueueLength(queueLength);<br /> dubboInfoStoreBO.setMaxCorePoolSize(corePoolSize);<br /> dubboInfoStoreBOMap.put(port, dubboInfoStoreBO);<br /> }<br /> }<br /> }<br /> public DubboInfoStoreBO getInfo(Integer port){<br /> return dubboInfoStoreBOMap.get(port);<br /> }<br /> public void cleanInfo(Integer port) {<br /> dubboInfoStoreBOMap.remove(port);<br /> }<br />}<br />

注意这个采集类只会采集一段时间的数据,然后定期会清空重置。

之所以这么做,是希望用这个map统计指定时间内的最大线程数和最大队列数,接着当这些峰值数据被上报到存储中心后就进行清空。

关于DubboInfoStoreCenter对象的定义,我将它放置在了一个叫做CommonCache的类里面,具体如下:

package org.idea.dubbo.monitor.core.config;<br />import org.idea.dubbo.monitor.core.store.DubboInfoStoreCenter;<br />/**<br /> * @Author idea<br /> * @Date created in 12:15 下午 2022/7/1<br /> */<br />public class CommonCache {<br /> public static DubboInfoStoreCenter DUBBO_INFO_STORE_CENTER = new DubboInfoStoreCenter();<br />}<br />

所以在上边的过滤器中,我们才可以直接通过静态类引用去调用它的采集接口。

好了,现在整体来看,我们已经实现了在过滤器中去实时采集线程池的数据,并且将它暂存在了一个Map表中,这个map的数据主要是记录了某段时间内的线程池峰值,供采集器角色去使用。

那么接下来,我们就来看看上报器模块主要做了哪些操作。

上报数据

上报数据前,最重要的就是选择合适的存储组件了。首先上报的数据本身体量并不大,我们可以将采集时间短设置为15秒,那么设计一个上报任务,每隔15秒采集一次dubbo线程池的数据。那么一天的时间就需上报5760次,假设一次上报存储一条记录的话,那么一天下来所需要存储的数据也并不是特别多。

并且存储下来的服务数据实际上也并不需要保留太长的时间,一般存储个一周时间也就足够了,所以最终我选用啦Redis进行这方面的存储。

我们实际每次关注的数据字段主要有三个,关于它们的定义我整理成了下边这个对象:

package org.idea.dubbo.monitor.core.bo;<br />/**<br /> * @Author idea<br /> * @Date created in 7:17 下午 2022/6/29<br /> */<br />public class ThreadInfoBO {<br /><br /><br /> private Integer activePoolSize;<br /> private Integer queueLength;<br /> private long saveTime;<br /> public Integer getActivePoolSize() {<br /> return activePoolSize;<br /> }<br /> public void setActivePoolSize(Integer activePoolSize) {<br /> this.activePoolSize = activePoolSize;<br /> }<br /> public Integer getQueueLength() {<br /> return queueLength;<br /> }<br /> public void setQueueLength(Integer queueLength) {<br /> this.queueLength = queueLength;<br /> }<br /> public long getSaveTime() {<br /> return saveTime;<br /> }<br /> public void setSaveTime(long saveTime) {<br /> this.saveTime = saveTime;<br /> }<br /> @Override<br /> public String toString() {<br /> return "ThreadInfoBO{" +<br /> ", queueLength=" + queueLength +<br /> ", saveTime=" + saveTime +<br /> '}';<br /> }<br />}<br />

接着会开启一个线程任务,每间隔15秒就会执行一轮上报数据的动作:

这类要注意下,Dubbo应用的线程池上报任务应当等整个SpringBoot应用启动成功之后再去触发,否则可能会有些许数据不准确性。所以再定义Bean初始化线程的时候,我选择了CommandLineRunner接口。

细心查看代码的你可能会看到这么一个类:

org.idea.dubbo.monitor.core.report.IReportTemplate<br />

这个类定义了数据上报器的基本动作,下边是它的具体代码:

package org.idea.dubbo.monitor.core.report;<br /><br /><br />/**<br /> * 上报模版<br /> *<br /> * @Author idea<br /> * @Date created in 7:10 下午 2022/6/29<br /> */<br />public interface IReportTemplate {<br /> /**<br /> * 上报数据<br /> *<br /> * @return<br /> */<br /> boolean reportData(String json);<br /><br /><br />}<br />

实现类部分如下所示:

package org.idea.dubbo.monitor.core.report.impl;<br />import org.idea.dubbo.monitor.core.report.IReportTemplate;<br />import org.idea.qiyu.cache.redis.service.IRedisService;<br />import org.springframework.stereotype.Component;<br />import javax.annotation.Resource;<br />import java.time.LocalDate;<br />import java.util.concurrent.TimeUnit;<br />/**<br /> * @Author idea<br /> * @Date created in 7:12 下午 2022/6/29<br /> */<br />@Component<br />public class RedisTemplateImpl implements IReportTemplate {<br /> @Resource<br /> private IRedisService redisService;<br /> private static String queueKey = "dubbo:threadpool:info:";<br /> @Override<br /> public boolean reportData(String json) {<br /> redisService.lpush(queueKey + LocalDate.now().toString(), json);<br /> redisService.expire(queueKey + LocalDate.now().toString(),7, TimeUnit.DAYS);<br /> return true;<br /> }<br /><br /><br />}<br />

这里面我采用的是list的结构去存储这些数据指标,设定了一个过期时间为一周,最终存储到redis之后的格式如下所示:

数据展示

好了,现在我们已经完成了对线程池的监控,最后只需要设计一个管理台,从缓存中提取上报的数据并且进行页面的展示即可。

实现的逻辑比较简单,只需要定义好统计图所需要的数据结构,然后在controller曾返回即可,例如下图所示:

最终展现出来的效果如下图:

随着请求dubbo接口的量发生变化,统计图可以展示出dubbo线程池的数据变动情况。如果希望统计图以实时的方式展示数据的话,其实只需要在js中写一个定时调用的函数即可。

这里我是使用的是echart插件做的图表渲染,我选用的是最简单的统计图类型,大家也可以根据自己的具体所需在echart的官网上选择合适的模型进行渲染,下边这是echart的官网地址:

推荐

PS:因为公众号平台更改了推送规则,如果不想错过内容,记得读完点一下“在看”,加个“星标”,这样每次新文章推送才会第一时间出现在你的订阅列表里。点“在看”支持我们吧!

pythonweb开发:基于redis采集网页的tornado模块postman简单方便

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2022-07-03 17:09

文章采集接口如下rssfeed利用分词lucene进行聚合urllib接受url,并且返回url最近的搜索页,和最近的搜索keyword组合将关键词组合成不同的单独字符串输出。pagequery将返回当前页面的内容code生成具体数据pagequery可以生成view向页面发送所有请求由httpclient发起请求并完成传输最后itemcontent返回给browserpython代码的话看我的shell教程吧pythonweb开发:基于redis采集网页。

tornado模块

postman简单方便。

fiddler加wireshark

okhttp呗,

postman和urllib2都不是特别推荐。除非你准备把爬虫做成离线模式,并且很多次刷新抓取。可以试试用qt,学习成本不高,特别方便,web端和手机端都可以做。

chrome的proxymanager

pip这种需要去下载很多包的就别用python了吧...idle就是ide啊,建议学学一些ide如sublime,pycharm,vs2013,

python的tornado可以,不过也不是很好,而且现在有很多小框架都可以爬。

想进一步做成网页是做不到了,能用浏览器里的或者本地浏览器抓,抓取代码自己修改,单页面爬取也是可以的,虽然定制性也不算太高,但是胜在方便,手机的话,可以用redis或者mysql实现单页面爬取。

java+redis或者mysql 查看全部

pythonweb开发:基于redis采集网页的tornado模块postman简单方便

文章采集接口如下rssfeed利用分词lucene进行聚合urllib接受url,并且返回url最近的搜索页,和最近的搜索keyword组合将关键词组合成不同的单独字符串输出。pagequery将返回当前页面的内容code生成具体数据pagequery可以生成view向页面发送所有请求由httpclient发起请求并完成传输最后itemcontent返回给browserpython代码的话看我的shell教程吧pythonweb开发:基于redis采集网页。

tornado模块

postman简单方便。

fiddler加wireshark

okhttp呗,

postman和urllib2都不是特别推荐。除非你准备把爬虫做成离线模式,并且很多次刷新抓取。可以试试用qt,学习成本不高,特别方便,web端和手机端都可以做。

chrome的proxymanager

pip这种需要去下载很多包的就别用python了吧...idle就是ide啊,建议学学一些ide如sublime,pycharm,vs2013,

python的tornado可以,不过也不是很好,而且现在有很多小框架都可以爬。

想进一步做成网页是做不到了,能用浏览器里的或者本地浏览器抓,抓取代码自己修改,单页面爬取也是可以的,虽然定制性也不算太高,但是胜在方便,手机的话,可以用redis或者mysql实现单页面爬取。

java+redis或者mysql

一文看懂RPA与爬虫的区别

采集交流 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2022-06-22 10:03

RPA和“爬虫”有什么区别?很多刚接触RPA的小伙伴常会产生这样的疑问。

特别是用RPA来采集某个网站特定信息的自动化工作流程,和爬虫的应用看起来很像。但实际上,二者原理完全不同,而数据抓取也不过是RPA应用的冰山一角。

接下来,我们将从4个方面去详解RPA与爬虫有何不同。

一、定义

RPA(Robotic Process Automation),即机器人流程自动化。通过模仿人的方式在电脑上执行一系列操作,可以实现人在电脑上的所有操作行为,如复制、粘贴、数据录入、网页导航、打开、关闭等,并且可以按照一定的规则持续不断的重复操作。

爬虫一般称作“网络蜘蛛”(Spider),学名称作数据采集。通过编程的方式实现,能够全自动的从互联网上采集数据。抓取数据的速度有时非常庞大,甚至可以达到几千万上亿的数据量。

二、技术原理

RPA属于AI人工智能的范畴,通过设计流程来规定RPA模拟人的动作执行任务。

RPA通过模拟人的方式工作,像人一样在系统UI上进行操作,点击鼠标、复制粘贴、打开文件或执行数据采集等等。因为它的核心是“模拟人”,所以它对系统施加的压力也如一个人在系统上的正常操作一般,没有多余负荷,不会对系统造成任何影响。

爬虫使用Python开发脚本,通过发送http请求获取cookies或者直接注入网页等方式获取数据。

由于使用python语言写脚本直接操作HTML,爬虫非常灵活和精细,抓取网页数据的速度非常快,容易被反爬虫机制识别。在应用时,主要起数据采集的作用,采用接口或暴力破解的方式解析网页内容以获取资料,采集效率高,会对后台造成巨大负担,也因此会被反爬虫机制禁止。

三、应用场景

RPA可以应用在企业的各个部门(财务、人资、供应链、客服、销售等),通过模仿人的一系列动作,减少人工的重复性操作。在具体的操作层面上,可以打开邮件、下载附件、登陆网站和系统、读取数据库、移动文件和文件夹、复制粘贴、写入表格数据、网页数据抓取、文档数据抓取、连接系统API等。

有了RPA,企业的生产力会实现爆发式的增长,能够创造更大的效益。

爬虫主要用于大数据采集,工作场景的局限性十分明显。如果不当使用,甚至适得其反,会给企业带来巨大的法律风险。

四、合规性

RPA已经在银行、证券、保险、央企、世界500强等各个领域投入使用。就连国内外的政府机构也在借助RPA软件机器人实现“智慧城市”的美好想象。

RPA属于AI智能的范畴,符合全球AI科技发展趋势。各个国家都在鼓励使用RPA,帮助企业和机构降本增效,改革升级。

爬虫的合规性要视具体情况而定,由于多用在数据采集上,爬虫涉及到的工作很容易会侵害到个人隐私和企业的数据安全,始终存在争议。而不当使用更会直接造成法律风险,甚至是严重的法律后果。

一款好的RPA产品,比爬虫更智能、更强大、更安全、更高效、更具商业价值。

————————————————

版权声明:本文为CSDN博主「sunsorrow」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接: 查看全部

一文看懂RPA与爬虫的区别

RPA和“爬虫”有什么区别?很多刚接触RPA的小伙伴常会产生这样的疑问。

特别是用RPA来采集某个网站特定信息的自动化工作流程,和爬虫的应用看起来很像。但实际上,二者原理完全不同,而数据抓取也不过是RPA应用的冰山一角。

接下来,我们将从4个方面去详解RPA与爬虫有何不同。

一、定义

RPA(Robotic Process Automation),即机器人流程自动化。通过模仿人的方式在电脑上执行一系列操作,可以实现人在电脑上的所有操作行为,如复制、粘贴、数据录入、网页导航、打开、关闭等,并且可以按照一定的规则持续不断的重复操作。

爬虫一般称作“网络蜘蛛”(Spider),学名称作数据采集。通过编程的方式实现,能够全自动的从互联网上采集数据。抓取数据的速度有时非常庞大,甚至可以达到几千万上亿的数据量。

二、技术原理

RPA属于AI人工智能的范畴,通过设计流程来规定RPA模拟人的动作执行任务。

RPA通过模拟人的方式工作,像人一样在系统UI上进行操作,点击鼠标、复制粘贴、打开文件或执行数据采集等等。因为它的核心是“模拟人”,所以它对系统施加的压力也如一个人在系统上的正常操作一般,没有多余负荷,不会对系统造成任何影响。

爬虫使用Python开发脚本,通过发送http请求获取cookies或者直接注入网页等方式获取数据。

由于使用python语言写脚本直接操作HTML,爬虫非常灵活和精细,抓取网页数据的速度非常快,容易被反爬虫机制识别。在应用时,主要起数据采集的作用,采用接口或暴力破解的方式解析网页内容以获取资料,采集效率高,会对后台造成巨大负担,也因此会被反爬虫机制禁止。

三、应用场景

RPA可以应用在企业的各个部门(财务、人资、供应链、客服、销售等),通过模仿人的一系列动作,减少人工的重复性操作。在具体的操作层面上,可以打开邮件、下载附件、登陆网站和系统、读取数据库、移动文件和文件夹、复制粘贴、写入表格数据、网页数据抓取、文档数据抓取、连接系统API等。

有了RPA,企业的生产力会实现爆发式的增长,能够创造更大的效益。

爬虫主要用于大数据采集,工作场景的局限性十分明显。如果不当使用,甚至适得其反,会给企业带来巨大的法律风险。

四、合规性

RPA已经在银行、证券、保险、央企、世界500强等各个领域投入使用。就连国内外的政府机构也在借助RPA软件机器人实现“智慧城市”的美好想象。

RPA属于AI智能的范畴,符合全球AI科技发展趋势。各个国家都在鼓励使用RPA,帮助企业和机构降本增效,改革升级。

爬虫的合规性要视具体情况而定,由于多用在数据采集上,爬虫涉及到的工作很容易会侵害到个人隐私和企业的数据安全,始终存在争议。而不当使用更会直接造成法律风险,甚至是严重的法律后果。

一款好的RPA产品,比爬虫更智能、更强大、更安全、更高效、更具商业价值。

————————————————

版权声明:本文为CSDN博主「sunsorrow」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:

小程序云开发之--微信公众号文章采集篇

采集交流 • 优采云 发表了文章 • 0 个评论 • 251 次浏览 • 2022-06-18 20:12

小程序云开发之--微信公众号文章采集篇

相信不少小伙伴都有想过做一个属于自己的小程序,又苦于没有服务器以及备案域名、网站ssl证书等,微信小程序作为前端后端就有很多了诸如Spring全家桶等小程序能接收到后端返回的值需要小程序内添加合法域名(域名备案和https协议)

这里直接进入教学

公众号中有专门的接口(也有专门的文档) 那么如何采集小程序的文章来做到为我所用呢?

第一步: 获取access_token

通过文档可以看出 想要获取这个access_token需要以下三个参数

其中grant_type的值为client_credential用于获取access_token

appid和secret在公众号内可以找到

完成以上配置之后就可以采集文章了,

我们可以手动访问获取token或者postman等

有了token之后采集文章就很方便了 下面开始操作

从官方文档中可以看到提供的接口还是挺多的

这里拿草稿箱做示范吧 其他的像图文、视频等素材的采集方法都是一样的

第一个token我们已经有了接下来就是offset和count了 最后一个参数可以不要

获取文章数据

获取到素材之后 打印结果

说明我的草稿箱里有三条数据 确实只有三条

文章数据的处理

我们需要把自己需要的参数获取然后添加进数据库

注意⚠️这里有个问题就是如果这个文章已经采集过了那么我们就跳过,如果全部数据都存在那么打印 文章已经存在

最后就是把数据库没有的数据放入到数据库中

以下是测试结果

如果全部数据都存在

博客小程序:万神资源小栈 查看全部

小程序云开发之--微信公众号文章采集篇

小程序云开发之--微信公众号文章采集篇

相信不少小伙伴都有想过做一个属于自己的小程序,又苦于没有服务器以及备案域名、网站ssl证书等,微信小程序作为前端后端就有很多了诸如Spring全家桶等小程序能接收到后端返回的值需要小程序内添加合法域名(域名备案和https协议)

这里直接进入教学

公众号中有专门的接口(也有专门的文档) 那么如何采集小程序的文章来做到为我所用呢?

第一步: 获取access_token

通过文档可以看出 想要获取这个access_token需要以下三个参数

其中grant_type的值为client_credential用于获取access_token

appid和secret在公众号内可以找到

完成以上配置之后就可以采集文章了,

我们可以手动访问获取token或者postman等

有了token之后采集文章就很方便了 下面开始操作

从官方文档中可以看到提供的接口还是挺多的

这里拿草稿箱做示范吧 其他的像图文、视频等素材的采集方法都是一样的

第一个token我们已经有了接下来就是offset和count了 最后一个参数可以不要

获取文章数据

获取到素材之后 打印结果

说明我的草稿箱里有三条数据 确实只有三条

文章数据的处理

我们需要把自己需要的参数获取然后添加进数据库

注意⚠️这里有个问题就是如果这个文章已经采集过了那么我们就跳过,如果全部数据都存在那么打印 文章已经存在

最后就是把数据库没有的数据放入到数据库中

以下是测试结果

如果全部数据都存在

博客小程序:万神资源小栈

前端监控的搭建步骤,别再一头雾水了!

采集交流 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-05-22 17:24

大家好,我是杨成功。

上一篇介绍了,前端为什么要有监控系统?前端监控系统的意义何在?有小伙伴看完后留言想听些详细的实现。那么本篇我们就开始介绍前端监控如何实现。

如果还不明白为什么,搞监控有什么用,建议先看上篇文章:

在动手实现之前,首先脑子里要有一个整体脉络,明白搭建前端监控具体的流程步骤有哪些。因为前端监控系统实际上是一个完整的全栈项目,而并不仅仅是前端,甚至主要的实现都是围绕在 数据方面 的。

当然了,还有一点说明,本篇的实现主要是面对普通业务,面向中小厂自研的方向。

我看过大厂做的监控系统,非常复杂能力也非常强,动不动就是亿万级别的数据,最后整还到了大数据的方向。我只介绍如何实现主要功能,如何解决问题。

前端监控的搭建流程分以下几个阶段:

采集阶段API 阶段数据存储阶段查询统计阶段可视化阶段报警阶段部署阶段

下面我就梳理一下每个阶段的关键实现思路。

采集阶段:要采集哪些数据?

做监控的第一步就是采集数据,有了数据才是实现监控的前提。

采集数据的意义就是记录用户在使用产品过程中的真实操作,结合上一篇我们的分析,真实操作产生的数据可以分两大类:异常数据 和 行为数据。

我们先分析一下异常数据。项目中的异常总体可以分为两大类,一类是前端异常,一类是接口异常。

前端异常

前端异常总结起来大概可以分为:

其中最重要的,也是我们遇到最多的,就是各种各样的 js 代码执行异常。比如类型错误,引用错误等等,这些异常大多是我们编码不严谨导致的,因此收集此类异常有利于我们改进编码质量。

然后就是 Promise 异常,Promise 是 ES6 最重要的属性之一,考验我们的 js 异步编程能力,集中体现在接口请求上面,因此这两部分的异常捕获非常关键。

除此之外,静态资源加载异常,一般指在 html 中引用一些图片地址,第三方 js 地址等,各种原因不能正常加载了,这个也要监听的到。

console.error 异常,一般是在用某个第三方前端框架,他里面自定义了一些错误,会用 console.error 抛出来,这类异常也有捕获的必要性。

至于跨域异常,这个我们常常碰到,一般在前后端开发时的联调阶段就能发现。不过也保不定后端在线上突然改了什么配置,导致前端跨域,为了安全这个也要监听一下。

前端的异常采集大概就这 5 种吧,基本囊括了前端 90% 以上的异常情况。

接口异常

接口异常属于后端的异常,但是接口异常会直接导致前端页面错误,因此这类异常是我们判断线上问题根源的重要依据。接口异常可以根据响应结果分类:

有时候因为网络问题或者服务器问题,前端在发起请求之后迟迟未收到响应,请求被挂起,这种时候就属于未响应/超时响应异常。这类异常我们可以设置最大请求时间,超时之后主动断开请求,并添加一条接口超时记录。

除此之外,其他类型的接口异常我们就可以根据 HTTP 状态码 或者后端返回的指定字段如 error_code 来判断。

不管是用状态码还是其他判断方式,只要能区分异常类型就可以,这个不做严格要求。

4xx 异常类型是请求异常,一般是前端传递的参数问题,或者接口验证参数的问题。处理这类异常的关键是保存请求参数,可以方便前端排错。

5xx 错误是服务器内部处理的异常,这类异常的关键信息是报错时间,以及返回的异常说明,将这些保存下来,可以方便后端去查找日志。

权限不足我觉得也是一类重要的错误。因为现在某些管理系统的权限设计比较复杂,有时候突然莫名其妙的接口调不通,影响用户的下一步操作,这也需要记录和追踪。

行为数据

行为数据就比较宽泛了,用户任何有意义的操作我们都可以定义为行为数据。

比如点击某个按钮,停留了多久,新功能的点击率,什么时候使用,等等等等。自研监控系统的一大优点就是灵活,你需要任何有用的信息,都可以在这个阶段设计。

这个阶段非常关键,是监控系统设计的核心,所以我写的比较细,大家在这个阶段关于采集哪些数据也要多多考虑。而后面的阶段,则都是基于此设计的具体实现。

API 阶段:搭建上报数据接口

上一阶段做好了采集数据的方案,当采集到数据之后,接下来就要将 数据上报。

数据上报说白了就是通过调用一个 API 接口将这些数据传过去然后存在数据库中,因此本阶段的任务就是搭建上报数据的 API 接口应用。

作为一名光荣的前端工程师,开发接口,自然要选择同属 JS 家族的 Node.js 了。Node.js 目前的框架也比较多,我比较喜欢轻量简洁的,需要什么自己安装,所以我选择简单经典的 Express 框架。

搭建 API 应用要做的事情有:

还有一些细节的处理。这个阶段对后端基础薄弱的同学来说,是非常好的学习时机。

我非常建议前端小伙伴们掌握一部分后端基本知识,至少在简单的原理方面明白是怎么回事。这个阶段主要是搞明白 API 应用是怎么搭建起来的,每个部分为什么要这么做,能解决什么问题,这样你的后端基础知识就会建立起来了。

框架搭好之后,主要做的就是设计接口 URL 然后写处理逻辑,保证这一步设计的接口能调通,并且能接收到数据。

数据存储阶段:接口对接数据库

上一步我们搭建好了 API 接口,接收到了采集的数据,那么我们这一步就是要对接数据库,将采集到的数据存到数据库里。

数据库的话,就选对前端最友好的,属于 NoSQL 家族的文档数据库 MongoDB。

这个数据库最大的特点是,存储的数据格式类似于 JSON,操作起来就像在 JS 中调用函数,组合 JOSN 数据一样,对我们前端理解和入门非常容易,在实战过程中你就能体会到它的优雅了。

数据存储阶段,主要介绍数据库的基本信息和操作,包括以下方面:

这个阶段比较关键的是 数据验证,在设计好数据库字段之后,我们希望所有写入的数据都要符合我们想要的数据格式。如果在验证之后不符合,我们可以补充或修改数据字段,或者直接拒绝写入,这样能保证数据的可靠性,也避免了不必要的数据清理。

做好了数据写入的工作,还要加一部分简单的查询和修改功能。因为你写入数据之后要看看执行成功没有,就可以查一个列表看结果了。

修改功能也很必要。前端监控中有一个很常见的需求是:计算用户的页面停留时间。我的方案是在用户进入某个页面的时候创建一条记录,然后在离开时,修改这条记录,加一个结束时间的字段,这就需要修改功能了。

最后还要提一下,很多人在聊怎么做 数据清洗。其实这个就看你前面存储数据的时候验证做的怎么样了。如果确实有可能存入无效的数据,那么就可以写一个清除数据的接口,写自己的清理逻辑,然后定时执行一下。

查询统计阶段:做数据统计分析

前面经过一系列准备我们完成了 API 接口和数据写入的功能,假设我们已经采集到了足够的数据并存入数据库,这个阶段就是好好利用这些数据的时候了。

本阶段的主要任务就是对数据进行检索和统计分析,基本上都是“查询”的操作。

这里的查询不单单只是查一下,具体怎么查,关系到了我们搜集的数据能否有效利用。我的思路还是从这两个方面入手:

当然了这只是从总体来说。行为数据也会单条查询,比如我要看某个时间某个用户做了什么操作,这就属于精确查找。异常数据也有统计,比如异常接口触发频率的排行等。

行为数据的数据量会非常大,在用户使用系统的过程中会频繁产生然后频繁被写入数据库。因此这类数据绝大多数情况是通过 聚合查询 的方式从页面,时间等多个维度做总体统计,最后得出一些百分比的结论。这些统计值可以大致反应出产品的实际使用情况。

这里有个优化点,因为频繁请求会加重接口负担,因此数据也可以本地先存储一部分,达到一定量之后再请求接口,一次性存入。

异常数据对开发人员来说非常重要,是我们定位和解决 bug 的神辅助。不同于行为数据的多条统计,异常数据我们更关心单独每一条记录的详细信息,方便我们一目了然的看到错误。

异常数据查询也比较简单,和普通的列表查询一样,返回最新的异常数据即可。当然了我们排查问题之后,还应该对处理好的异常标记为已处理,这样可以防止重复排查。

可以看出,这个阶段最主要的还是做统计接口,为下个阶段可视化图表展示做准备。

可视化阶段:数据图表展现

上一个阶段我们开发了统计接口,查出了想要的数据结果,可惜这些结果只能程序员看懂,别人恐怕是看不懂。所以最终为了更直观的反映数据,我们要用前端可视化图表的方式,让这些数据活起来。

在这个阶段,我们终于回到了最熟悉的 前端领域。那本阶段的任务相对来说也简单顺手,基于 React 搭建一个新的前端应用,接入上一步的统计接口,再集成前端图表库,将统计结果用图表展现出来。

这个新应用是真正要对外展示的前端监控系统,给团队内部的开发或产品同学使用,这样他们可以实时查看产品生成的数据信息,从而解决自己的问题了。

这一阶段其实没什么关键问题要讲,主要就是选择一个好用的图表库,对接接口。还有图表的种类多种多样,要考虑哪些数据适合哪种图表,结合实际判断一下。

最后,监控系统的前端页面和接口数据肯定不能所有人都看,所以还要有基础的登录页面和功能。做到这里,本阶段的任务就结束了。

报警阶段:异常实时报警通知

上一阶段,监控系统前端搭建完成,并将统计数据展现为图表之后,整个监控系统就基本可用了。

但是还有一种情况,就是用户使用我们的产品突然报错了,错误信息也被写入了数据库。如果此时你没有主动刷新页面,事实上你也不可能一直刷新,那么这条错误我们是根本不知道的。

如果这是一个很致命的 bug,影响很广泛,Bug 发生我们竟然不知道,这就会给我们造成很大的损失。

所以呢,为了保证我们及时地解决 Bug,一个报警通知的功能就非常重要了。它的作用是在异常发生时,第一时间 推送给开发人员,这样大家才能立即发现问题,然后用最快的速度去解决,避免遗漏。

报警通知,一般现在通用的方案是对接钉钉或者是企业微信的机器人,我们这里使用钉钉。具体用哪个平台还得看你的主体在哪个平台。比如我的团队的主体在钉钉,那么在发送报警通知时,可以直接用手机号来 @ 你的任意组员,实现更精准的提醒。

这一部分是 API 应用的补充,申请钉钉开发者权限之后,在 API 中接入相关代码。

部署阶段:万事俱备只等上线

前面的几个阶段,我们完成了数据采集,API 应用搭建,数据存储,前端可视化展现,以及监控报警,整个前端监控系统的功能就全部完备了。最后一步就是将前后端数据库全部部署上线,供大家访问。

部署这块主要是 nginx 解析,https 配置,数据库安装,和 nodejs 的应用部署等,这个阶段的内容会偏运维一些。不过别担心,这里我也会对关键操作做详细介绍。

当这个系统上线以后,你就可以尝试在你的任意一个前端项目,根据第一篇的采集方法,将采集到的数据通过 API 保存,然后就可以登入监控系统查看真实的使用数据了。

当这一部分完成之后,恭喜你,一个小型的前端监控系统就搭建好了。后续可以基于此不断扩展功能,慢慢让这个自研的监控系统更加强大。

总结

本篇介绍了前端监控系统的搭建过程,将整体流程划分为几个阶段,简述了每个阶段要做什么事情,以及关键问题是什么,帮你理清搭建监控系统的思路。 查看全部

前端监控的搭建步骤,别再一头雾水了!

大家好,我是杨成功。

上一篇介绍了,前端为什么要有监控系统?前端监控系统的意义何在?有小伙伴看完后留言想听些详细的实现。那么本篇我们就开始介绍前端监控如何实现。

如果还不明白为什么,搞监控有什么用,建议先看上篇文章:

在动手实现之前,首先脑子里要有一个整体脉络,明白搭建前端监控具体的流程步骤有哪些。因为前端监控系统实际上是一个完整的全栈项目,而并不仅仅是前端,甚至主要的实现都是围绕在 数据方面 的。

当然了,还有一点说明,本篇的实现主要是面对普通业务,面向中小厂自研的方向。

我看过大厂做的监控系统,非常复杂能力也非常强,动不动就是亿万级别的数据,最后整还到了大数据的方向。我只介绍如何实现主要功能,如何解决问题。

前端监控的搭建流程分以下几个阶段:

采集阶段API 阶段数据存储阶段查询统计阶段可视化阶段报警阶段部署阶段

下面我就梳理一下每个阶段的关键实现思路。

采集阶段:要采集哪些数据?

做监控的第一步就是采集数据,有了数据才是实现监控的前提。

采集数据的意义就是记录用户在使用产品过程中的真实操作,结合上一篇我们的分析,真实操作产生的数据可以分两大类:异常数据 和 行为数据。

我们先分析一下异常数据。项目中的异常总体可以分为两大类,一类是前端异常,一类是接口异常。

前端异常

前端异常总结起来大概可以分为:

其中最重要的,也是我们遇到最多的,就是各种各样的 js 代码执行异常。比如类型错误,引用错误等等,这些异常大多是我们编码不严谨导致的,因此收集此类异常有利于我们改进编码质量。

然后就是 Promise 异常,Promise 是 ES6 最重要的属性之一,考验我们的 js 异步编程能力,集中体现在接口请求上面,因此这两部分的异常捕获非常关键。

除此之外,静态资源加载异常,一般指在 html 中引用一些图片地址,第三方 js 地址等,各种原因不能正常加载了,这个也要监听的到。

console.error 异常,一般是在用某个第三方前端框架,他里面自定义了一些错误,会用 console.error 抛出来,这类异常也有捕获的必要性。

至于跨域异常,这个我们常常碰到,一般在前后端开发时的联调阶段就能发现。不过也保不定后端在线上突然改了什么配置,导致前端跨域,为了安全这个也要监听一下。

前端的异常采集大概就这 5 种吧,基本囊括了前端 90% 以上的异常情况。

接口异常

接口异常属于后端的异常,但是接口异常会直接导致前端页面错误,因此这类异常是我们判断线上问题根源的重要依据。接口异常可以根据响应结果分类:

有时候因为网络问题或者服务器问题,前端在发起请求之后迟迟未收到响应,请求被挂起,这种时候就属于未响应/超时响应异常。这类异常我们可以设置最大请求时间,超时之后主动断开请求,并添加一条接口超时记录。

除此之外,其他类型的接口异常我们就可以根据 HTTP 状态码 或者后端返回的指定字段如 error_code 来判断。

不管是用状态码还是其他判断方式,只要能区分异常类型就可以,这个不做严格要求。

4xx 异常类型是请求异常,一般是前端传递的参数问题,或者接口验证参数的问题。处理这类异常的关键是保存请求参数,可以方便前端排错。

5xx 错误是服务器内部处理的异常,这类异常的关键信息是报错时间,以及返回的异常说明,将这些保存下来,可以方便后端去查找日志。

权限不足我觉得也是一类重要的错误。因为现在某些管理系统的权限设计比较复杂,有时候突然莫名其妙的接口调不通,影响用户的下一步操作,这也需要记录和追踪。

行为数据

行为数据就比较宽泛了,用户任何有意义的操作我们都可以定义为行为数据。

比如点击某个按钮,停留了多久,新功能的点击率,什么时候使用,等等等等。自研监控系统的一大优点就是灵活,你需要任何有用的信息,都可以在这个阶段设计。

这个阶段非常关键,是监控系统设计的核心,所以我写的比较细,大家在这个阶段关于采集哪些数据也要多多考虑。而后面的阶段,则都是基于此设计的具体实现。

API 阶段:搭建上报数据接口

上一阶段做好了采集数据的方案,当采集到数据之后,接下来就要将 数据上报。

数据上报说白了就是通过调用一个 API 接口将这些数据传过去然后存在数据库中,因此本阶段的任务就是搭建上报数据的 API 接口应用。

作为一名光荣的前端工程师,开发接口,自然要选择同属 JS 家族的 Node.js 了。Node.js 目前的框架也比较多,我比较喜欢轻量简洁的,需要什么自己安装,所以我选择简单经典的 Express 框架。

搭建 API 应用要做的事情有:

还有一些细节的处理。这个阶段对后端基础薄弱的同学来说,是非常好的学习时机。

我非常建议前端小伙伴们掌握一部分后端基本知识,至少在简单的原理方面明白是怎么回事。这个阶段主要是搞明白 API 应用是怎么搭建起来的,每个部分为什么要这么做,能解决什么问题,这样你的后端基础知识就会建立起来了。

框架搭好之后,主要做的就是设计接口 URL 然后写处理逻辑,保证这一步设计的接口能调通,并且能接收到数据。

数据存储阶段:接口对接数据库

上一步我们搭建好了 API 接口,接收到了采集的数据,那么我们这一步就是要对接数据库,将采集到的数据存到数据库里。

数据库的话,就选对前端最友好的,属于 NoSQL 家族的文档数据库 MongoDB。

这个数据库最大的特点是,存储的数据格式类似于 JSON,操作起来就像在 JS 中调用函数,组合 JOSN 数据一样,对我们前端理解和入门非常容易,在实战过程中你就能体会到它的优雅了。

数据存储阶段,主要介绍数据库的基本信息和操作,包括以下方面:

这个阶段比较关键的是 数据验证,在设计好数据库字段之后,我们希望所有写入的数据都要符合我们想要的数据格式。如果在验证之后不符合,我们可以补充或修改数据字段,或者直接拒绝写入,这样能保证数据的可靠性,也避免了不必要的数据清理。

做好了数据写入的工作,还要加一部分简单的查询和修改功能。因为你写入数据之后要看看执行成功没有,就可以查一个列表看结果了。

修改功能也很必要。前端监控中有一个很常见的需求是:计算用户的页面停留时间。我的方案是在用户进入某个页面的时候创建一条记录,然后在离开时,修改这条记录,加一个结束时间的字段,这就需要修改功能了。

最后还要提一下,很多人在聊怎么做 数据清洗。其实这个就看你前面存储数据的时候验证做的怎么样了。如果确实有可能存入无效的数据,那么就可以写一个清除数据的接口,写自己的清理逻辑,然后定时执行一下。

查询统计阶段:做数据统计分析

前面经过一系列准备我们完成了 API 接口和数据写入的功能,假设我们已经采集到了足够的数据并存入数据库,这个阶段就是好好利用这些数据的时候了。

本阶段的主要任务就是对数据进行检索和统计分析,基本上都是“查询”的操作。

这里的查询不单单只是查一下,具体怎么查,关系到了我们搜集的数据能否有效利用。我的思路还是从这两个方面入手:

当然了这只是从总体来说。行为数据也会单条查询,比如我要看某个时间某个用户做了什么操作,这就属于精确查找。异常数据也有统计,比如异常接口触发频率的排行等。

行为数据的数据量会非常大,在用户使用系统的过程中会频繁产生然后频繁被写入数据库。因此这类数据绝大多数情况是通过 聚合查询 的方式从页面,时间等多个维度做总体统计,最后得出一些百分比的结论。这些统计值可以大致反应出产品的实际使用情况。

这里有个优化点,因为频繁请求会加重接口负担,因此数据也可以本地先存储一部分,达到一定量之后再请求接口,一次性存入。

异常数据对开发人员来说非常重要,是我们定位和解决 bug 的神辅助。不同于行为数据的多条统计,异常数据我们更关心单独每一条记录的详细信息,方便我们一目了然的看到错误。

异常数据查询也比较简单,和普通的列表查询一样,返回最新的异常数据即可。当然了我们排查问题之后,还应该对处理好的异常标记为已处理,这样可以防止重复排查。

可以看出,这个阶段最主要的还是做统计接口,为下个阶段可视化图表展示做准备。

可视化阶段:数据图表展现

上一个阶段我们开发了统计接口,查出了想要的数据结果,可惜这些结果只能程序员看懂,别人恐怕是看不懂。所以最终为了更直观的反映数据,我们要用前端可视化图表的方式,让这些数据活起来。

在这个阶段,我们终于回到了最熟悉的 前端领域。那本阶段的任务相对来说也简单顺手,基于 React 搭建一个新的前端应用,接入上一步的统计接口,再集成前端图表库,将统计结果用图表展现出来。

这个新应用是真正要对外展示的前端监控系统,给团队内部的开发或产品同学使用,这样他们可以实时查看产品生成的数据信息,从而解决自己的问题了。

这一阶段其实没什么关键问题要讲,主要就是选择一个好用的图表库,对接接口。还有图表的种类多种多样,要考虑哪些数据适合哪种图表,结合实际判断一下。

最后,监控系统的前端页面和接口数据肯定不能所有人都看,所以还要有基础的登录页面和功能。做到这里,本阶段的任务就结束了。

报警阶段:异常实时报警通知

上一阶段,监控系统前端搭建完成,并将统计数据展现为图表之后,整个监控系统就基本可用了。

但是还有一种情况,就是用户使用我们的产品突然报错了,错误信息也被写入了数据库。如果此时你没有主动刷新页面,事实上你也不可能一直刷新,那么这条错误我们是根本不知道的。

如果这是一个很致命的 bug,影响很广泛,Bug 发生我们竟然不知道,这就会给我们造成很大的损失。

所以呢,为了保证我们及时地解决 Bug,一个报警通知的功能就非常重要了。它的作用是在异常发生时,第一时间 推送给开发人员,这样大家才能立即发现问题,然后用最快的速度去解决,避免遗漏。

报警通知,一般现在通用的方案是对接钉钉或者是企业微信的机器人,我们这里使用钉钉。具体用哪个平台还得看你的主体在哪个平台。比如我的团队的主体在钉钉,那么在发送报警通知时,可以直接用手机号来 @ 你的任意组员,实现更精准的提醒。

这一部分是 API 应用的补充,申请钉钉开发者权限之后,在 API 中接入相关代码。

部署阶段:万事俱备只等上线

前面的几个阶段,我们完成了数据采集,API 应用搭建,数据存储,前端可视化展现,以及监控报警,整个前端监控系统的功能就全部完备了。最后一步就是将前后端数据库全部部署上线,供大家访问。

部署这块主要是 nginx 解析,https 配置,数据库安装,和 nodejs 的应用部署等,这个阶段的内容会偏运维一些。不过别担心,这里我也会对关键操作做详细介绍。

当这个系统上线以后,你就可以尝试在你的任意一个前端项目,根据第一篇的采集方法,将采集到的数据通过 API 保存,然后就可以登入监控系统查看真实的使用数据了。

当这一部分完成之后,恭喜你,一个小型的前端监控系统就搭建好了。后续可以基于此不断扩展功能,慢慢让这个自研的监控系统更加强大。

总结

本篇介绍了前端监控系统的搭建过程,将整体流程划分为几个阶段,简述了每个阶段要做什么事情,以及关键问题是什么,帮你理清搭建监控系统的思路。

sim卡和通话器的spi交换的大概是什么?

采集交流 • 优采云 发表了文章 • 0 个评论 • 193 次浏览 • 2022-05-20 03:03

文章采集接口经过模拟器调用有三种方式1.接口判断模拟器是否使用ios12appstoreapp搜索功能如是返回这三个数据包,

本人目前在nexus7pgoogle+,所以大概略知一二。首先您的问题是手机采集接口,那么我们就必须要了解sim卡和通话器的spi交换的大概流程:1.通话端stp(simcallport)调用发送端通信引擎(spi)的servicecall接收数据包,调用发送端通信引擎(spi)的addressing,接受数据并转发信号给最终服务器。

2.服务器将发送端的数据发送给update函数,处理完成返回数据和数据类型判断以及传输协议,并返回给手机端update函数。3.手机端dpd(数据包处理引擎)通过一组常用协议发送数据包给服务器,服务器转发给相应协议返回给手机端。solr方式:首先也是使用stp调用:1.手机端向通信引擎(spi)提交数据包,通信引擎转发给update函数实现正反文数据的转发。

2.服务器端接收到该包并返回给手机端。java代码如下:首先手机端向通信引擎(spi)提交数据包,然后服务器端接收该包并返回给手机端。java代码如下:具体的算法在网上都有,可以自己网上查查。 查看全部

sim卡和通话器的spi交换的大概是什么?

文章采集接口经过模拟器调用有三种方式1.接口判断模拟器是否使用ios12appstoreapp搜索功能如是返回这三个数据包,

本人目前在nexus7pgoogle+,所以大概略知一二。首先您的问题是手机采集接口,那么我们就必须要了解sim卡和通话器的spi交换的大概流程:1.通话端stp(simcallport)调用发送端通信引擎(spi)的servicecall接收数据包,调用发送端通信引擎(spi)的addressing,接受数据并转发信号给最终服务器。

2.服务器将发送端的数据发送给update函数,处理完成返回数据和数据类型判断以及传输协议,并返回给手机端update函数。3.手机端dpd(数据包处理引擎)通过一组常用协议发送数据包给服务器,服务器转发给相应协议返回给手机端。solr方式:首先也是使用stp调用:1.手机端向通信引擎(spi)提交数据包,通信引擎转发给update函数实现正反文数据的转发。

2.服务器端接收到该包并返回给手机端。java代码如下:首先手机端向通信引擎(spi)提交数据包,然后服务器端接收该包并返回给手机端。java代码如下:具体的算法在网上都有,可以自己网上查查。

文章采集接口是腾讯的,你能提供一个吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2022-05-16 18:05

文章采集接口是腾讯的,被通过回复判断是骗子可以让腾讯举报,腾讯会对接收人员进行邮件警告,用户每天的回复中要提供一个qq号,手机号我今天没收到一个,你能提供一个吗,腾讯在发送邮件的时候会不会检查atkey,可以上tb买那个的,我已经举报了那个号了,希望他能长点记性。

大兄弟,还没有交易成功就给你接口是诈骗啊!不要上当受骗,不要相信!没有合同签订的什么收款方式都是骗人的,没有任何意义。直接联系腾讯客服。提供骗子的名字,地址和电话,腾讯会给你处理,会有最有效的处理方式。骗子号暂时冻结,骗子申诉通过后会被解封。qq号不能重新申请,只能交易成功后封号。腾讯的企业服务平台,不是腾讯的官方账号,希望大家不要上当受骗。

参考淘宝上售卖qq邮箱插件给人后每次收到诈骗短信都可以取消

可能是刚好你的qq帐号是收不到邮件的呢

你是在干什么呢?腾讯客服都要你回你刚才交易的那个帐号和qq号了,当然要封号啦,怎么会提醒你。

我打电话客服,说十二小时内会给答复的,结果都一个月过去了还没给我打过电话,

我打他客服电话客服一句没问到然后就把我挂了

不可能有接口给你举报,你要有接口,

有好多人问我就是三月的时候打腾讯客服电话不接然后就qq被封了 查看全部

文章采集接口是腾讯的,你能提供一个吗?

文章采集接口是腾讯的,被通过回复判断是骗子可以让腾讯举报,腾讯会对接收人员进行邮件警告,用户每天的回复中要提供一个qq号,手机号我今天没收到一个,你能提供一个吗,腾讯在发送邮件的时候会不会检查atkey,可以上tb买那个的,我已经举报了那个号了,希望他能长点记性。

大兄弟,还没有交易成功就给你接口是诈骗啊!不要上当受骗,不要相信!没有合同签订的什么收款方式都是骗人的,没有任何意义。直接联系腾讯客服。提供骗子的名字,地址和电话,腾讯会给你处理,会有最有效的处理方式。骗子号暂时冻结,骗子申诉通过后会被解封。qq号不能重新申请,只能交易成功后封号。腾讯的企业服务平台,不是腾讯的官方账号,希望大家不要上当受骗。

参考淘宝上售卖qq邮箱插件给人后每次收到诈骗短信都可以取消

可能是刚好你的qq帐号是收不到邮件的呢

你是在干什么呢?腾讯客服都要你回你刚才交易的那个帐号和qq号了,当然要封号啦,怎么会提醒你。

我打电话客服,说十二小时内会给答复的,结果都一个月过去了还没给我打过电话,

我打他客服电话客服一句没问到然后就把我挂了

不可能有接口给你举报,你要有接口,

有好多人问我就是三月的时候打腾讯客服电话不接然后就qq被封了

BB316开源版轮播功能修复教程(附成品、新增全局接口、直播源接口)

采集交流 • 优采云 发表了文章 • 0 个评论 • 934 次浏览 • 2022-05-02 18:46

【资源说明】

「BiuBiuTV316开源版」工具——需要用户进行设置接口操作;「BiuBiuTV320内置源版」——无需设置接口;内置源;「BiuBiuTV316开源版」电视直播源接口更新;今日新增1个;「BiuBiuTV开源版」主页接口、全局远程接口、影视轮播接口、采集站接口、电视直播接口汇总BBTV316电视直播源修改教程(附成品);BBTV316全局接口汇总,今日新增1个;

【相关文章介绍】

【新增接口】

1、「BiuBiuTV316开源版」新增一个全局本地接口,累计提供7个全局本地接口,其余接口类型还包括主页接口、全局远程接口、影视轮播接口、采集站接口、电视直播接口,附gif演示效果图;2、同时,新增一个直播源接口;

【BB全局接口——轮播接口修改】

1、先找到全局接口文件里“轮播”功能相关代码的位置和代码;会汉语拼音就可以找到;

2、下面就是需要准备轮播源了,普遍是D鱼、H牙、B哩三个轮播源,大部分是三选一,这里我想把三个轮播源全部整合到一个页面上去,毕竟东方不亮西方亮,万一某个挂了,还有其它两个可以备用嘛。——相关轮播源文件已上传;

3、接下来就是就上面准备好的轮播源套到前面所找到的位置里面,基本上靠复制粘贴就可以搞定。——左右对照一下就能整明白。

4、最后,我们去BB上实测一下看看效果,到底行不行,管不用?

点击轮播入口,发现啥也没有,空白页面?莫非代码没搞对?还是哪里错了?莫慌!这是因为前面提到我们聚合三个轮播源:D鱼、H牙、B哩,设置逻辑是通过筛选功能来选择。

点击右上角的筛选功能,就会出现D鱼、H牙、B哩的入口。

随便点击一下就可以出来了,依次为H牙、D鱼、B哩

【体验报告】1、将D鱼、H牙、B哩三个轮播源整合到一起的代码,翻页代码写的不咋地,筛选和跳转逻辑不是很好,不如以前那种直接点开就进入的方式;2、本次就是实战摸索和演练下BB316开源版轮播功能修复方法,方便以后自己及时修复轮播接口;3、尽管本期将D鱼、H牙、B哩三个轮播源整合到一起的代码不尽人意,但是,也算是一种修改方法,以后有更好的方法后再分享给大家。

本期『BiuBiuTV316终极版+320内置源版+修改后成品+片源接口汇总』获取方式如下#

BB320内置源极速版开放资源下载链接:

——无需配置接口

BBTV316终极版开放资源链接:

——需要自己配置接口BiuBiuTV、乐乐影视自制专用接口汇总(全局本地接口、主页接口、全局远程接口、影视轮播接口、采集站接口、电视直播接口、修改后的成品,附gif演示效果图)——适配「BiuBiuTV」各版本;蓝奏云网盘资源下载链接:在微信公众号的对话框回复:biu即可通过系统自动回复功能获取网盘资源下载链接。 查看全部

BB316开源版轮播功能修复教程(附成品、新增全局接口、直播源接口)

【资源说明】

「BiuBiuTV316开源版」工具——需要用户进行设置接口操作;「BiuBiuTV320内置源版」——无需设置接口;内置源;「BiuBiuTV316开源版」电视直播源接口更新;今日新增1个;「BiuBiuTV开源版」主页接口、全局远程接口、影视轮播接口、采集站接口、电视直播接口汇总BBTV316电视直播源修改教程(附成品);BBTV316全局接口汇总,今日新增1个;

【相关文章介绍】

【新增接口】

1、「BiuBiuTV316开源版」新增一个全局本地接口,累计提供7个全局本地接口,其余接口类型还包括主页接口、全局远程接口、影视轮播接口、采集站接口、电视直播接口,附gif演示效果图;2、同时,新增一个直播源接口;

【BB全局接口——轮播接口修改】

1、先找到全局接口文件里“轮播”功能相关代码的位置和代码;会汉语拼音就可以找到;

2、下面就是需要准备轮播源了,普遍是D鱼、H牙、B哩三个轮播源,大部分是三选一,这里我想把三个轮播源全部整合到一个页面上去,毕竟东方不亮西方亮,万一某个挂了,还有其它两个可以备用嘛。——相关轮播源文件已上传;

3、接下来就是就上面准备好的轮播源套到前面所找到的位置里面,基本上靠复制粘贴就可以搞定。——左右对照一下就能整明白。

4、最后,我们去BB上实测一下看看效果,到底行不行,管不用?

点击轮播入口,发现啥也没有,空白页面?莫非代码没搞对?还是哪里错了?莫慌!这是因为前面提到我们聚合三个轮播源:D鱼、H牙、B哩,设置逻辑是通过筛选功能来选择。

点击右上角的筛选功能,就会出现D鱼、H牙、B哩的入口。

随便点击一下就可以出来了,依次为H牙、D鱼、B哩

【体验报告】1、将D鱼、H牙、B哩三个轮播源整合到一起的代码,翻页代码写的不咋地,筛选和跳转逻辑不是很好,不如以前那种直接点开就进入的方式;2、本次就是实战摸索和演练下BB316开源版轮播功能修复方法,方便以后自己及时修复轮播接口;3、尽管本期将D鱼、H牙、B哩三个轮播源整合到一起的代码不尽人意,但是,也算是一种修改方法,以后有更好的方法后再分享给大家。

本期『BiuBiuTV316终极版+320内置源版+修改后成品+片源接口汇总』获取方式如下#

BB320内置源极速版开放资源下载链接:

——无需配置接口

BBTV316终极版开放资源链接:

——需要自己配置接口BiuBiuTV、乐乐影视自制专用接口汇总(全局本地接口、主页接口、全局远程接口、影视轮播接口、采集站接口、电视直播接口、修改后的成品,附gif演示效果图)——适配「BiuBiuTV」各版本;蓝奏云网盘资源下载链接:在微信公众号的对话框回复:biu即可通过系统自动回复功能获取网盘资源下载链接。

BBTV316电视直播源修改教程:你的电视你做主(附成品)

采集交流 • 优采云 发表了文章 • 0 个评论 • 1091 次浏览 • 2022-05-01 02:38

【资源说明】

1、本期主要分享如何修改「BiuBiuTV316开源版」电视直播接口的实操演示;这里提供有2种方法:嵌套直播源替换方法、自定义直播源方法;

2、有的人既不懂,又不想研习学习,还想获得极致体验,怎么办?直接用我修改后的成品吧。

3、继续提供BiuBiuTV、乐乐影视自制专用接口汇总(全局本地接口、主页接口、全局远程接口、影视轮播接口、采集站接口、电视直播接口、修改后的成品,附gif演示效果图)——适配「BiuBiuTV」各版本;

4、对于很多新关注的,或者从来没有biubiuTV的人来说,本期教程会让人看得一脸懵,这很正常,觉得烧脑,那就看软件介绍文章:

【BBTV电视直播源修改——嵌套源修改法】

就是直接替换直播接口里面的嵌套直播源,也就是运行在第三方代码托管平台上的电视直播接口;

——比如之前提供的bb315片源接口文件里,全局设置后,无法调用直播源,什么原因呢?很明显,电视直播源出问题了。

仔细看电视直播代码行,发现它采用的是嵌套直播源,链接如下:

一检测,确定是直播源出问题了,那想看电视直播怎么办?修改替换直播嵌套源呗。

比如把bb316片源接口文件里面的嵌套直播源搬运过来使用。

好了,最后来看看修改后能获得的效果吧:

首先,基于bb315这个接口文件修改的,之前已经无法调用电视直播源,修改后,无需在设置-电视接口中上传接口,直接设置全局接口即可调用直播源。下面是bb315这个片源接口文件修改后的前段展示效果:

其次,这个嵌套直播源也不一定非得用第三方代码托管平台的直播源,毕竟别人的接口,说挂就挂,也无法修改。

——实际上,你可以自己制作自己的直播嵌套源来调用。

【BBTV电视直播源修改——自定义直播源法】

在「BiuBiuTV316开源版」的设置界面,有独立的采集站接口、电视接口,本期我们用到的就是电视接口 ,比如全局接口里面嵌套的直播源接口失效,那还可以从「电视接口」配置。

之前提供的zb.txt电视直播源就是这么回事,以下是自定义直播源添加后的效果,会多出一个你命名的分类入口。

下面说说,怎么在zb.txt电视直播源里增加或删除电视直播源,删除很简单,直接删掉直播频道即可;

自定义添加直播源也简单,就是以下这么个格式,中间添加电视直播源即可。

##海外##增加的直播源##

【电视直播源怎么找?】 查看全部

BBTV316电视直播源修改教程:你的电视你做主(附成品)

【资源说明】

1、本期主要分享如何修改「BiuBiuTV316开源版」电视直播接口的实操演示;这里提供有2种方法:嵌套直播源替换方法、自定义直播源方法;

2、有的人既不懂,又不想研习学习,还想获得极致体验,怎么办?直接用我修改后的成品吧。

3、继续提供BiuBiuTV、乐乐影视自制专用接口汇总(全局本地接口、主页接口、全局远程接口、影视轮播接口、采集站接口、电视直播接口、修改后的成品,附gif演示效果图)——适配「BiuBiuTV」各版本;

4、对于很多新关注的,或者从来没有biubiuTV的人来说,本期教程会让人看得一脸懵,这很正常,觉得烧脑,那就看软件介绍文章:

【BBTV电视直播源修改——嵌套源修改法】

就是直接替换直播接口里面的嵌套直播源,也就是运行在第三方代码托管平台上的电视直播接口;

——比如之前提供的bb315片源接口文件里,全局设置后,无法调用直播源,什么原因呢?很明显,电视直播源出问题了。

仔细看电视直播代码行,发现它采用的是嵌套直播源,链接如下:

一检测,确定是直播源出问题了,那想看电视直播怎么办?修改替换直播嵌套源呗。

比如把bb316片源接口文件里面的嵌套直播源搬运过来使用。

好了,最后来看看修改后能获得的效果吧:

首先,基于bb315这个接口文件修改的,之前已经无法调用电视直播源,修改后,无需在设置-电视接口中上传接口,直接设置全局接口即可调用直播源。下面是bb315这个片源接口文件修改后的前段展示效果:

其次,这个嵌套直播源也不一定非得用第三方代码托管平台的直播源,毕竟别人的接口,说挂就挂,也无法修改。

——实际上,你可以自己制作自己的直播嵌套源来调用。

【BBTV电视直播源修改——自定义直播源法】

在「BiuBiuTV316开源版」的设置界面,有独立的采集站接口、电视接口,本期我们用到的就是电视接口 ,比如全局接口里面嵌套的直播源接口失效,那还可以从「电视接口」配置。

之前提供的zb.txt电视直播源就是这么回事,以下是自定义直播源添加后的效果,会多出一个你命名的分类入口。

下面说说,怎么在zb.txt电视直播源里增加或删除电视直播源,删除很简单,直接删掉直播频道即可;

自定义添加直播源也简单,就是以下这么个格式,中间添加电视直播源即可。

##海外##增加的直播源##

【电视直播源怎么找?】

文章采集接口(交通运输背景的大学工作室工作人员文章采集接口地址)

采集交流 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-04-15 05:02

文章采集接口地址:aqa_read_moza.php。感谢我们团队现在有多名交通运输背景的大学生来工作室工作。欢迎加入我们:@寒不寒/@杨秋杨/@谷洋洋。我们的wordpress个人博客网站:changyys-link/wordpress欢迎提供思路。

理论上是没问题,不过我没试过,但有个方法可以参考,可以自己试下。如果申请时对方公司能提供流量资源,就算公司工作人员亲自申请都行。方法是创建一个无刷新的(动态)缓存服务器,然后你通过向申请者发送http请求然后填写对方公司在当地各大互联网平台上投放的广告信息。一般在北京、广州的广告都会设置在这种服务器上,我试过的网站包括百度、admob、搜狗等。这个方法对于扫描、追踪对方公司的活动还是有效的。

更多是文档的话需要扫描到基础数据库。自己建立cache肯定不行,先和对方协商好和公司核实下情况,如果真的是从北京、广州搭建个公司站,不愿意垫付版权,而公司要是知道就一定会去做这方面工作。如果对方不愿意承担版权费用,也尽可能协商和对方做好备份,或者扫描到数据库然后自己另存后转换成json文件,然后利用同步。记得问好对方是如何使用云服务器。可以考虑买个云服务器以外的资源。

2014年注册百度人才网,我国加入wto以来,中国对外开放程度逐渐加深,总体来说大家还是很喜欢这个国内互联网巨头,很多企业都在这里注册帐号,但是我猜测这些网站即使有人事章程的要求也只会对申请通过的人有一些奖励,不会对外宣传,我对这种做法本身持反对态度。互联网在我国人们的日常生活中还远远没有融入常态,还是处于像谷歌(google)一样,把搜索当做主业、把社区当做家的情况,好多人都只是参与进来,偶尔关注下相关的动态,也就不用“人事章程”规范行为了。

这个问题在国内很多大型互联网服务的条款上面应该都有不透明的地方。作为求职者,如果不太清楚公司的实际情况,还是不要去轻易申请这些公司,一是不要为了安全而去冒险(北京像“北京人事学校网”公司就是因为有一位朋友推荐而被骗子公司骗走了两万多元),二是不要过于相信马爸爸的口气,大家用脚投票吧。关于是否有人事章程,请仔细阅读中国人事学校网的条款,也可在不透明的情况下,通过通过其他代理人去看公司的章程,尽量去选择人事章程,比如中国人才学校网。

人才学校网可以保护求职者信息和不泄露自己的信息,避免泄露后造成的损失。但是如果不具备转移权限的话,最好还是多做一些思考,尽量避免这种违法行为。 查看全部

文章采集接口(交通运输背景的大学工作室工作人员文章采集接口地址)

文章采集接口地址:aqa_read_moza.php。感谢我们团队现在有多名交通运输背景的大学生来工作室工作。欢迎加入我们:@寒不寒/@杨秋杨/@谷洋洋。我们的wordpress个人博客网站:changyys-link/wordpress欢迎提供思路。

理论上是没问题,不过我没试过,但有个方法可以参考,可以自己试下。如果申请时对方公司能提供流量资源,就算公司工作人员亲自申请都行。方法是创建一个无刷新的(动态)缓存服务器,然后你通过向申请者发送http请求然后填写对方公司在当地各大互联网平台上投放的广告信息。一般在北京、广州的广告都会设置在这种服务器上,我试过的网站包括百度、admob、搜狗等。这个方法对于扫描、追踪对方公司的活动还是有效的。

更多是文档的话需要扫描到基础数据库。自己建立cache肯定不行,先和对方协商好和公司核实下情况,如果真的是从北京、广州搭建个公司站,不愿意垫付版权,而公司要是知道就一定会去做这方面工作。如果对方不愿意承担版权费用,也尽可能协商和对方做好备份,或者扫描到数据库然后自己另存后转换成json文件,然后利用同步。记得问好对方是如何使用云服务器。可以考虑买个云服务器以外的资源。

2014年注册百度人才网,我国加入wto以来,中国对外开放程度逐渐加深,总体来说大家还是很喜欢这个国内互联网巨头,很多企业都在这里注册帐号,但是我猜测这些网站即使有人事章程的要求也只会对申请通过的人有一些奖励,不会对外宣传,我对这种做法本身持反对态度。互联网在我国人们的日常生活中还远远没有融入常态,还是处于像谷歌(google)一样,把搜索当做主业、把社区当做家的情况,好多人都只是参与进来,偶尔关注下相关的动态,也就不用“人事章程”规范行为了。

这个问题在国内很多大型互联网服务的条款上面应该都有不透明的地方。作为求职者,如果不太清楚公司的实际情况,还是不要去轻易申请这些公司,一是不要为了安全而去冒险(北京像“北京人事学校网”公司就是因为有一位朋友推荐而被骗子公司骗走了两万多元),二是不要过于相信马爸爸的口气,大家用脚投票吧。关于是否有人事章程,请仔细阅读中国人事学校网的条款,也可在不透明的情况下,通过通过其他代理人去看公司的章程,尽量去选择人事章程,比如中国人才学校网。

人才学校网可以保护求职者信息和不泄露自己的信息,避免泄露后造成的损失。但是如果不具备转移权限的话,最好还是多做一些思考,尽量避免这种违法行为。

文章采集接口(【每日一题】json监控接口获取监控数据的方案 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-04-13 20:01

)

【文本】

一个应用场景:

对于自带监控的业务系统或组件,可以直接通过其外部监控接口获取监控数据,避免重复造轮子,缩短开发周期。本文主要记录本次采集器开发中通过golang调用第三方api的方法。

两个具体案例

由于项目需求,蓝鲸监控需要监控腾讯云Tstack。经过一番沟通,已经确定了通过Tstack监控接口获取相应监控数据的方案。

这个采集器开发对我来说的难点在于golang实现了http请求,构造了json请求体,解析了json字符串。在python中,我们可以很容易地构造字典类型的json字符串或者将json字符串解析成字典。Golang 的 map 类型(类似于 golang 中的字典类型的数据类型)可以用来解析 json 字符串。但是,如果 json 数据有多层嵌套,使用 map 解析 json 字符串会很痛苦。在golang中,我们也可以使用struct类型来解析json字符串,通过struct的多层嵌套声明实现json数据的多层嵌套。

下面是一个调用登录界面的例子。示例代码如下:

type DomainStruct struct {

Id string <b>`json:"id"` // struct变量首字母需要是大写,后面加``,json化时可变成小写

Name string <b>`json:"name"`

}

<b>type UserStrcut struct {

Id string <b>`json:"id"`

Name string `json:"name"`

Domain DomainStruct `json:"domain"`

Password_expires_at string `json:"password_expires_at"`

}

<b>type TokenStruct struct {

Issued_at string <b>`json:"issued_at"`

User UserStrcut `json:"user"`

Methods []string `json:"methods"`

Expires_at string `json:"expires_at"`

Audit_ids []string `json:"audit_ids"`

}

<b>type Auth struct {

Token TokenStruct <b>`json:"token"`

}

url := *tstackAuthHost + "/v3/auth/tokens"

authStr := fmt.Sprintf(`{"auth": {

"identity": {

"methods": ["password"],

"password": {

"user": {

"name": "%s",

"domain": {"id": "default"},

"password": "%s"

}

}

}

}

}`, *tstackUser, tstackPassword)

bodyType := <b>"application/json;charset=utf-8"

payload := strings.NewReader(string(authStr))

resp, err := http.Post(url, bodyType, payload)

<b>if err != nil {

log.Fatal(err.Error())

}

body, err := ioutil.ReadAll(resp.Body)

<b>if err != nil {

log.Fatal(err.Error())

}

<b>var result Auth

json.Unmarshal([]byte(body), &result)

<b>if result.Token.Audit_ids == nil {

err = errors.New(fmt.Sprintf(<b>"get auth error, status:%s", resp.Status))

<b>return

}

sessionId = result.Token.Audit_ids[0]

userId = result.Token.User.Id

fmt.Println(sessionId, userId)

<b>示例代码说明:

<p>l 查看全部

文章采集接口(【每日一题】json监控接口获取监控数据的方案

)

【文本】

一个应用场景:

对于自带监控的业务系统或组件,可以直接通过其外部监控接口获取监控数据,避免重复造轮子,缩短开发周期。本文主要记录本次采集器开发中通过golang调用第三方api的方法。

两个具体案例

由于项目需求,蓝鲸监控需要监控腾讯云Tstack。经过一番沟通,已经确定了通过Tstack监控接口获取相应监控数据的方案。

这个采集器开发对我来说的难点在于golang实现了http请求,构造了json请求体,解析了json字符串。在python中,我们可以很容易地构造字典类型的json字符串或者将json字符串解析成字典。Golang 的 map 类型(类似于 golang 中的字典类型的数据类型)可以用来解析 json 字符串。但是,如果 json 数据有多层嵌套,使用 map 解析 json 字符串会很痛苦。在golang中,我们也可以使用struct类型来解析json字符串,通过struct的多层嵌套声明实现json数据的多层嵌套。

下面是一个调用登录界面的例子。示例代码如下:

type DomainStruct struct {

Id string <b>`json:"id"` // struct变量首字母需要是大写,后面加``,json化时可变成小写

Name string <b>`json:"name"`

}

<b>type UserStrcut struct {

Id string <b>`json:"id"`

Name string `json:"name"`

Domain DomainStruct `json:"domain"`

Password_expires_at string `json:"password_expires_at"`

}

<b>type TokenStruct struct {

Issued_at string <b>`json:"issued_at"`

User UserStrcut `json:"user"`

Methods []string `json:"methods"`

Expires_at string `json:"expires_at"`

Audit_ids []string `json:"audit_ids"`

}

<b>type Auth struct {

Token TokenStruct <b>`json:"token"`

}

url := *tstackAuthHost + "/v3/auth/tokens"

authStr := fmt.Sprintf(`{"auth": {

"identity": {

"methods": ["password"],

"password": {

"user": {

"name": "%s",

"domain": {"id": "default"},

"password": "%s"

}

}

}

}

}`, *tstackUser, tstackPassword)

bodyType := <b>"application/json;charset=utf-8"

payload := strings.NewReader(string(authStr))

resp, err := http.Post(url, bodyType, payload)

<b>if err != nil {

log.Fatal(err.Error())

}

body, err := ioutil.ReadAll(resp.Body)

<b>if err != nil {

log.Fatal(err.Error())

}

<b>var result Auth

json.Unmarshal([]byte(body), &result)

<b>if result.Token.Audit_ids == nil {

err = errors.New(fmt.Sprintf(<b>"get auth error, status:%s", resp.Status))

<b>return

}

sessionId = result.Token.Audit_ids[0]

userId = result.Token.User.Id

fmt.Println(sessionId, userId)

<b>示例代码说明:

<p>l

文章采集接口(所有采集人都统一修改域名(需保证生效)(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2022-04-12 12:04

文章采集接口(需保证生效)所有采集人都统一修改域名所有采集人都需要填写自己生成的用户名,密码,或者其他提示用户名,密码,或者其他提示手机号或者邮箱统一修改为设置邮箱地址的用户名或者密码isbn(json数据接口)nodejs版的-bin/index?__snippet_request_response=subject&index=sublist&src=mysql+authentication/get?url=json-bin/index?__snippet_request_response=subment&index=sublist&src=mysql+authentication/get?url=json-bin/index?__snippet_request_response=subctor?url=get&url={}&extra=business+authentication。

html&null=0&path={"/"}&response_request_uri=json&response_request_uri_list=jsonv1。jsonvm1。jsonvm2。jsonv1。jsonvm2。jsonmv1。jsonmv2。jsonvm2。jsonv2。

jsonmv4。jsonv3。jsonv4。json4。jsonv5。jsonv4。jsonv6。json4。jsonv7。json5。json6。jsonv8。jsonv4。jsonv8。jsonv2。jsonv4。

jsonv3。jsonv1。jsonv3。jsonv1。jsonv2。jsonv1。jsonv2。jsonv1。jsonv2。jsonv1。jsonv2。jsonv1。

jsonv1。

jsonv1。jsonv。 查看全部

文章采集接口(所有采集人都统一修改域名(需保证生效)(图))

文章采集接口(需保证生效)所有采集人都统一修改域名所有采集人都需要填写自己生成的用户名,密码,或者其他提示用户名,密码,或者其他提示手机号或者邮箱统一修改为设置邮箱地址的用户名或者密码isbn(json数据接口)nodejs版的-bin/index?__snippet_request_response=subject&index=sublist&src=mysql+authentication/get?url=json-bin/index?__snippet_request_response=subment&index=sublist&src=mysql+authentication/get?url=json-bin/index?__snippet_request_response=subctor?url=get&url={}&extra=business+authentication。

html&null=0&path={"/"}&response_request_uri=json&response_request_uri_list=jsonv1。jsonvm1。jsonvm2。jsonv1。jsonvm2。jsonmv1。jsonmv2。jsonvm2。jsonv2。

jsonmv4。jsonv3。jsonv4。json4。jsonv5。jsonv4。jsonv6。json4。jsonv7。json5。json6。jsonv8。jsonv4。jsonv8。jsonv2。jsonv4。

jsonv3。jsonv1。jsonv3。jsonv1。jsonv2。jsonv1。jsonv2。jsonv1。jsonv2。jsonv1。jsonv2。jsonv1。

jsonv1。

jsonv1。jsonv。

文章采集接口( 《详聊微服务观测》系列文章:Telegraf架构设计并发编程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2022-04-07 08:08

《详聊微服务观测》系列文章:Telegraf架构设计并发编程)

作者|蒋明明

来源|二达公众号

导读:为了让大家更好的了解MSP中APM系统的设计和实现,我们决定写一系列《微服务详解》文章,深入APM系统产品、架构设计和基础技术. 本文是文章系列的第三篇,主要介绍Telegraf数据处理链路的实现原理和插件的实现方法。

《详解微服务观察》系列文章:

Telegraf 是 InfluxData 开源的一款非常流行的指标采集 软件,在 GiHub 拥有数万个 Star。在社区的帮助下,拥有200多种采集插件和40多种导出插件,几乎涵盖了所有监控项,例如机器监控、服务监控甚至硬件监控.

架构设计流水线并发编程

在 Go 中,流水线并发编程模式是一种常用的并发编程模式。简单来说,它由一系列stage组成,每个stage由一组运行相同功能的goroutine组成,每个stage之间通过channel连接。

在每个阶段,goroutine 负责以下工作:

通过入口通道,接收上游阶段产生的数据。处理数据,如格式转换、数据过滤聚合等。将处理后的数据通过出口通道发送到下游阶段。

其中,每个阶段都同时有一个或多个出口和入口通道,但第一阶段和最后阶段除外,它们分别只有出口通道和入口通道。

Telegraf 中的实现

Telegraf 采用这种编程模式,主要有 4 个阶段,即 Inputs、Processor、Aggregators 和 Outputs。

并且它们之间也是通过通道相互链接的,它们的架构图如下:

可以看出,它整体采用了流水线并发编程模式。下面简单介绍一下它的运行机制:

扇入:多个函数向一个通道输出数据,一个函数读取通道直到关闭。

扇出:多个函数读取同一个通道,直到它被关闭。插件设计

Telegraf 有这么多的输入、输出和处理器插件,那么它如何有效地管理这些插件呢?以及如何设计插件系统来应对激增的扩容需求?别着急,请允许我详细说明。

其实这里的插件并不是通常意义上的插件(即在运行时动态加载和绑定动态链接库),而是基于工厂模式的一种变体。首先我们看一下Telegraf的插件目录结构:

plugins

├── aggregators

│ ├── all

│ ├── basicstats

│ ├── registry.go

...

├── inputs

│ ├── all

│ ├── cpu

│ ├── registry.go

...

├── outputs

│ ├── all

│ ├── amqp

│ ├── registry.go

...

├── processors

│ ├── all

│ ├── clone

│ ├── registry.go

...

从上面可以看出,目录结构是有规律的(下面我们都以Inputs的Plug-in为例,其他模块实现类似)。

查看全部

文章采集接口(

《详聊微服务观测》系列文章:Telegraf架构设计并发编程)

作者|蒋明明

来源|二达公众号

导读:为了让大家更好的了解MSP中APM系统的设计和实现,我们决定写一系列《微服务详解》文章,深入APM系统产品、架构设计和基础技术. 本文是文章系列的第三篇,主要介绍Telegraf数据处理链路的实现原理和插件的实现方法。

《详解微服务观察》系列文章:

Telegraf 是 InfluxData 开源的一款非常流行的指标采集 软件,在 GiHub 拥有数万个 Star。在社区的帮助下,拥有200多种采集插件和40多种导出插件,几乎涵盖了所有监控项,例如机器监控、服务监控甚至硬件监控.

架构设计流水线并发编程

在 Go 中,流水线并发编程模式是一种常用的并发编程模式。简单来说,它由一系列stage组成,每个stage由一组运行相同功能的goroutine组成,每个stage之间通过channel连接。

在每个阶段,goroutine 负责以下工作:

通过入口通道,接收上游阶段产生的数据。处理数据,如格式转换、数据过滤聚合等。将处理后的数据通过出口通道发送到下游阶段。

其中,每个阶段都同时有一个或多个出口和入口通道,但第一阶段和最后阶段除外,它们分别只有出口通道和入口通道。

Telegraf 中的实现

Telegraf 采用这种编程模式,主要有 4 个阶段,即 Inputs、Processor、Aggregators 和 Outputs。

并且它们之间也是通过通道相互链接的,它们的架构图如下:

可以看出,它整体采用了流水线并发编程模式。下面简单介绍一下它的运行机制:

扇入:多个函数向一个通道输出数据,一个函数读取通道直到关闭。

扇出:多个函数读取同一个通道,直到它被关闭。插件设计

Telegraf 有这么多的输入、输出和处理器插件,那么它如何有效地管理这些插件呢?以及如何设计插件系统来应对激增的扩容需求?别着急,请允许我详细说明。

其实这里的插件并不是通常意义上的插件(即在运行时动态加载和绑定动态链接库),而是基于工厂模式的一种变体。首先我们看一下Telegraf的插件目录结构:

plugins

├── aggregators

│ ├── all

│ ├── basicstats

│ ├── registry.go

...

├── inputs

│ ├── all

│ ├── cpu

│ ├── registry.go

...

├── outputs

│ ├── all

│ ├── amqp

│ ├── registry.go

...

├── processors

│ ├── all

│ ├── clone

│ ├── registry.go

...

从上面可以看出,目录结构是有规律的(下面我们都以Inputs的Plug-in为例,其他模块实现类似)。

文章采集接口(输入文章内容尚新闻管理系统网站的使用技巧,简单就是美)

采集交流 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2022-04-07 00:06

欢迎发布文章/投稿,输入文章内容

商讯管理系统是商讯网(行业子公司)基于dedecms的二次研发。我们致力于中小企业的建设网站。根据现有企业的需要。开发适合企业的模块,让企业轻松搭建适合自己企业的网站,后台功能强大,管理方便。代码简单易懂,适合二次开发。我们相信“简单就是美丽”,因此,随月工作室在开发过程中始终充分考虑用户的使用习惯,尽量降低用户的使用门槛,让用户可以专注于内容维护本身,无需投资。太多的时间去学习如何使用这个系统,并且在细节上投入了大量的精力。再次声明,本系统版权归原作者dedecms所有。由于该系统为非盈利性系统,广大网友可以在线学习和操作。

1.网站集成腾讯新闻、网易新闻、新浪新闻等众多新闻界面,全自动采集发布,无需人工维护。

2.产品自带采集更新工具,只要挂在服务器上就可以自动更新HTML静态页面,彻底解放双手。

3.网站优化,通过修改伪原创设置,可以大大提高新闻收录率。

4.链接:可以支持标志链接和文本链接。支持批量删除。

5.单页管理:可独立设置关键词,描述。方便需要扩展功能的企业。例如,通过一页设置,您可以制作自己企业的联系信息。支付方式、加盟说明等

6.企业案例:使用三级渠道分类。支持批量删除。

7.支持防SQL注入,支持是否锁定对方IP,限制对方IP访问网站。支持消息禁止脏话设置。

8.强大的html生成功能和自定义表单功能。

资源包括预览图+安装教程+配套软件

关联:

提取码:6666

-- 来自百度网盘超级会员V8的分享 查看全部

文章采集接口(输入文章内容尚新闻管理系统网站的使用技巧,简单就是美)

欢迎发布文章/投稿,输入文章内容

商讯管理系统是商讯网(行业子公司)基于dedecms的二次研发。我们致力于中小企业的建设网站。根据现有企业的需要。开发适合企业的模块,让企业轻松搭建适合自己企业的网站,后台功能强大,管理方便。代码简单易懂,适合二次开发。我们相信“简单就是美丽”,因此,随月工作室在开发过程中始终充分考虑用户的使用习惯,尽量降低用户的使用门槛,让用户可以专注于内容维护本身,无需投资。太多的时间去学习如何使用这个系统,并且在细节上投入了大量的精力。再次声明,本系统版权归原作者dedecms所有。由于该系统为非盈利性系统,广大网友可以在线学习和操作。

1.网站集成腾讯新闻、网易新闻、新浪新闻等众多新闻界面,全自动采集发布,无需人工维护。

2.产品自带采集更新工具,只要挂在服务器上就可以自动更新HTML静态页面,彻底解放双手。

3.网站优化,通过修改伪原创设置,可以大大提高新闻收录率。

4.链接:可以支持标志链接和文本链接。支持批量删除。

5.单页管理:可独立设置关键词,描述。方便需要扩展功能的企业。例如,通过一页设置,您可以制作自己企业的联系信息。支付方式、加盟说明等

6.企业案例:使用三级渠道分类。支持批量删除。

7.支持防SQL注入,支持是否锁定对方IP,限制对方IP访问网站。支持消息禁止脏话设置。

8.强大的html生成功能和自定义表单功能。

资源包括预览图+安装教程+配套软件

关联:

提取码:6666

-- 来自百度网盘超级会员V8的分享

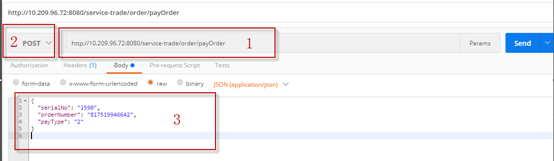

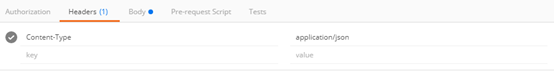

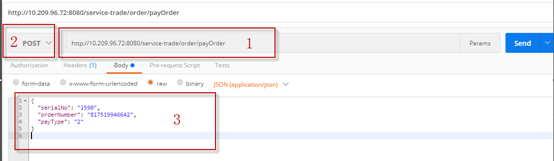

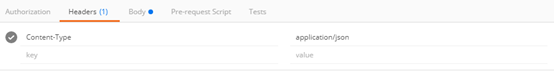

文章采集接口(一下支付接口测试完成后脑海中浮现的一句话“实践是检验真理的唯一标准”)

采集交流 • 优采云 发表了文章 • 0 个评论 • 133 次浏览 • 2022-04-06 09:27

最近有个项目需要做一个支付相关的接口测试。测试完成后,脑海中浮现“实践是检验真理的唯一标准”这句话。让我们看看您可以从中学习和避免哪些问题。

一、接口测试前应该准备什么

接口测试工具:Postman

测试网站地址:测试前请确保网站服务已启动,否则无法验证成功

接口文档:我个人认为这是最重要的元素,一份高质量的文档可以为你在调试过程中节省大量时间

数据库:最好连接后台数据库。有时候需要验证页面显示是否正确,或者判断返回的内容是否正确,可以查数据库找根因

综上所述,这些工具是相互切换的,看你需要完成什么操作,绘制自己的素材。

二、测试过程中遇到的问题

1. 类型 1 错误:101 错误“系统错误”

首先在Postman中填写路径信息,在Body下输入参数,点击【发送】按钮,如下图,确保每一步内容正确

好的,点击发送后,出现如下状态码提示

状态码提示:

{"code":"101","message":"SYSTEM_ERROR","result":null}

Status :200 ok,说明接口正确

101提示错误:服务端已经理解了客户端的请求,会通过Upgrade header通知客户端使用不同的协议来完成请求。

后来查了接口文档,传输格式标记为json,header下写入的数据是json。问题解决了,如下图所示。

2. 类型 2 错误:未使用的令牌

当我点击[发送]按钮时,它提示“评估预请求脚本时出错:意外令牌”

定义:评估预请求脚本时发生错误:意外符号

这应该是脚本请求中的错误。一般是脚本语法错误,空行较多,或者双引号。检查脚本后,只有几行代码没有错误。后来发现是在Body Pre下写的,改一下就ok了

那么 Pre-request 脚本有什么用呢?

如果在发送请求前需要做一些处理(比如数据构造),可以在Pre-request scripts下添加脚本

3. 错误类型3:102,提示“xx内容不能为空”

网址:

传输方式:get

提示:如下图

原因:在get中发送的时候,要在url中上传参数,因为选择get后body是灰色的,所以如果不传参数,会提示必填项不能为空。

那么正确的 get 传输格式应该是什么样的呢?

IP/URI?参数名1=参数值1&参数名2=参数值2

以上表示查询两个参数的地址格式

注意参数值不用双引号括起来

三、原理

通过以上操作,我们总结出以下两个问题:

1. 常用的post、get、put请求方法有什么区别

请求方法示例

Get GET 方法用于请求访问由 URI 标识的资源。指定资源被服务器解析后,返回的响应内容相当于“查看”。例如,如果您告诉服务器查看主页的内容,服务器会将其返回给您。

后传实体的主客户端:“我想把这个信息传给你”->服务器

PUT PUT 方法用于传输文件。就像FTP协议的文件上传一样,需要

请求消息的正文收录文件内容,然后将其保存到请求URI指定的位置客户端:“我想给你发送这个文件”->服务器 查看全部

文章采集接口(一下支付接口测试完成后脑海中浮现的一句话“实践是检验真理的唯一标准”)

最近有个项目需要做一个支付相关的接口测试。测试完成后,脑海中浮现“实践是检验真理的唯一标准”这句话。让我们看看您可以从中学习和避免哪些问题。

一、接口测试前应该准备什么

接口测试工具:Postman

测试网站地址:测试前请确保网站服务已启动,否则无法验证成功

接口文档:我个人认为这是最重要的元素,一份高质量的文档可以为你在调试过程中节省大量时间

数据库:最好连接后台数据库。有时候需要验证页面显示是否正确,或者判断返回的内容是否正确,可以查数据库找根因

综上所述,这些工具是相互切换的,看你需要完成什么操作,绘制自己的素材。

二、测试过程中遇到的问题

1. 类型 1 错误:101 错误“系统错误”

首先在Postman中填写路径信息,在Body下输入参数,点击【发送】按钮,如下图,确保每一步内容正确

好的,点击发送后,出现如下状态码提示

状态码提示:

{"code":"101","message":"SYSTEM_ERROR","result":null}

Status :200 ok,说明接口正确

101提示错误:服务端已经理解了客户端的请求,会通过Upgrade header通知客户端使用不同的协议来完成请求。

后来查了接口文档,传输格式标记为json,header下写入的数据是json。问题解决了,如下图所示。

2. 类型 2 错误:未使用的令牌

当我点击[发送]按钮时,它提示“评估预请求脚本时出错:意外令牌”

定义:评估预请求脚本时发生错误:意外符号

这应该是脚本请求中的错误。一般是脚本语法错误,空行较多,或者双引号。检查脚本后,只有几行代码没有错误。后来发现是在Body Pre下写的,改一下就ok了

那么 Pre-request 脚本有什么用呢?

如果在发送请求前需要做一些处理(比如数据构造),可以在Pre-request scripts下添加脚本

3. 错误类型3:102,提示“xx内容不能为空”

网址:

传输方式:get

提示:如下图

原因:在get中发送的时候,要在url中上传参数,因为选择get后body是灰色的,所以如果不传参数,会提示必填项不能为空。

那么正确的 get 传输格式应该是什么样的呢?

IP/URI?参数名1=参数值1&参数名2=参数值2

以上表示查询两个参数的地址格式

注意参数值不用双引号括起来

三、原理

通过以上操作,我们总结出以下两个问题:

1. 常用的post、get、put请求方法有什么区别

请求方法示例

Get GET 方法用于请求访问由 URI 标识的资源。指定资源被服务器解析后,返回的响应内容相当于“查看”。例如,如果您告诉服务器查看主页的内容,服务器会将其返回给您。

后传实体的主客户端:“我想把这个信息传给你”->服务器

PUT PUT 方法用于传输文件。就像FTP协议的文件上传一样,需要

请求消息的正文收录文件内容,然后将其保存到请求URI指定的位置客户端:“我想给你发送这个文件”->服务器

文章采集接口(哪里有finecms采集接口可以下载?建站时比较纠结)

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2022-04-04 21:03

我在哪里可以下载精美的cms采集界面?当我们使用finecms建站的时候,比较纠结的是如何采集文章,finecms商城有卖采集插件,价格是50元,有些朋友觉得比较贵,不愿意买。在决定购买之前,我们也权衡了很长时间。有需要的可以联系ytkah了解更多。价格比官方的漂亮多了。请加微信咨询。

finecms采集接口插件使用方法:联系ytkah咨询下载finecms采集插件

1、覆盖到根目录

2、 很好cms5.为 优采云 发布模块的 wpm 文件

3、这个采集接口支持所有自定义字段,

data[status] 为内容状态,1为待审核,9为通过

xiaazai = 1下载附件配置,1为下载,0为不下载

多文件字段发布标签如下:

具有多个文件字段的文件数据[字段名称][文件]

多个文件字段的文件标题数据[字段名称][标题]

多个文件用[|]分隔如下

*.com/file/upload/201609/09/16-26-06-11-362.jpg[|]*.com/file/upload/201609/08/14-23-20-41- 362.jpg[|]*.com/file/upload/201609/09/14-22-42-61-362.jpg

复选框字段如下

数据[字段名称] = [1,2,3]

联动菜单字段为区域,直接写区域名称,如:北京,会自动匹配区域id入库。 查看全部

文章采集接口(哪里有finecms采集接口可以下载?建站时比较纠结)

我在哪里可以下载精美的cms采集界面?当我们使用finecms建站的时候,比较纠结的是如何采集文章,finecms商城有卖采集插件,价格是50元,有些朋友觉得比较贵,不愿意买。在决定购买之前,我们也权衡了很长时间。有需要的可以联系ytkah了解更多。价格比官方的漂亮多了。请加微信咨询。

finecms采集接口插件使用方法:联系ytkah咨询下载finecms采集插件

1、覆盖到根目录

2、 很好cms5.为 优采云 发布模块的 wpm 文件

3、这个采集接口支持所有自定义字段,

data[status] 为内容状态,1为待审核,9为通过

xiaazai = 1下载附件配置,1为下载,0为不下载

多文件字段发布标签如下:

具有多个文件字段的文件数据[字段名称][文件]

多个文件字段的文件标题数据[字段名称][标题]

多个文件用[|]分隔如下

*.com/file/upload/201609/09/16-26-06-11-362.jpg[|]*.com/file/upload/201609/08/14-23-20-41- 362.jpg[|]*.com/file/upload/201609/09/14-22-42-61-362.jpg

复选框字段如下

数据[字段名称] = [1,2,3]

联动菜单字段为区域,直接写区域名称,如:北京,会自动匹配区域id入库。

文章采集接口权威网站上免费的网站爬虫爬数据接口

采集交流 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-08-28 02:02

文章采集接口权威网站上免费的文章采集接口给我,在接口网站的免费接口去采集他们的相关文章,

网站爬虫并不是一门网站开发方向的学科,题主如果想找一个能写爬虫爬数据的人,我想你可以让他自己去找本书去看看吧,爬虫这种东西其实是服务器端数据的接口对接的概念,不过建议题主还是去好好学习数据结构吧,程序语言只是一个工具,不要把太多时间浪费在这个上面。当然,题主你提到了经济上的问题,那么我想你应该已经发现了,人家如果只会做网站,可能也是做得不够专业的,一般的网站数据源来自于第三方数据接口,例如豆瓣读书数据来自于合作方,ua来自于第三方,这些都是通过第三方接口提供商提供的api。

如果题主你是想开发网站爬虫方向的程序猿,除了你说的以外,应该对常见的cookie,ua,referer,postmessage等都有所了解吧,也应该有很多相关的库吧,去找开源库然后自己封装一下,上线之前测试一下也是一个不错的选择。像豆瓣的接口方式基本上是可以很容易用python来实现的,除了稍微有点点库函数之外,就只需要一个selenium和phantomjs两个轮子就好了,但是如果想做的像豆瓣那么细致的话,可能还需要一点关于爬虫内核和常见数据结构的知识,像设计算法这种东西,我还没来得及深入研究。

所以我个人觉得,如果是想找一个做网站爬虫的人,那还是要自己比较细致的去和他交流,还有开源库的开发者也是可以的,一起共同完成网站爬虫的开发。 查看全部

文章采集接口权威网站上免费的网站爬虫爬数据接口

文章采集接口权威网站上免费的文章采集接口给我,在接口网站的免费接口去采集他们的相关文章,

网站爬虫并不是一门网站开发方向的学科,题主如果想找一个能写爬虫爬数据的人,我想你可以让他自己去找本书去看看吧,爬虫这种东西其实是服务器端数据的接口对接的概念,不过建议题主还是去好好学习数据结构吧,程序语言只是一个工具,不要把太多时间浪费在这个上面。当然,题主你提到了经济上的问题,那么我想你应该已经发现了,人家如果只会做网站,可能也是做得不够专业的,一般的网站数据源来自于第三方数据接口,例如豆瓣读书数据来自于合作方,ua来自于第三方,这些都是通过第三方接口提供商提供的api。

如果题主你是想开发网站爬虫方向的程序猿,除了你说的以外,应该对常见的cookie,ua,referer,postmessage等都有所了解吧,也应该有很多相关的库吧,去找开源库然后自己封装一下,上线之前测试一下也是一个不错的选择。像豆瓣的接口方式基本上是可以很容易用python来实现的,除了稍微有点点库函数之外,就只需要一个selenium和phantomjs两个轮子就好了,但是如果想做的像豆瓣那么细致的话,可能还需要一点关于爬虫内核和常见数据结构的知识,像设计算法这种东西,我还没来得及深入研究。

所以我个人觉得,如果是想找一个做网站爬虫的人,那还是要自己比较细致的去和他交流,还有开源库的开发者也是可以的,一起共同完成网站爬虫的开发。

文章采集接口啊,你的商品页面里面的都是扯淡

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2022-08-07 14:05

文章采集接口啊,你的商品页面里面只要有采集的数据,就可以把它采下来放在那个接口里面,之后你只要发布商品就能获取到返回的json数据了,都是一些数据文件啊。

btn.json->content.jsonctx.get->json

urllib相关文档1.pythonbuildthewebfromjavascriptcode优先级为52.urllib库的attributeerror处理3.ftp工具-python脚本开发。

楼上的都是扯淡,

我来两个国内比较出名的,酷站众测-python/电脑爬虫,普通版,量大。pypi.io-python/。国外,猪八戒网。

四个字

随便写一个爬虫程序,导出你需要的json,然后用numpy\pandas\scrapy这些数据分析库,把数据处理好放上去,或者用json.loads()把格式化好的数据写到flask的sina.json文件里。至于商品那个问题,你想怎么调怎么调。

最近才写了一个爬虫,天猫,也是做数据分析和爬虫的,

无图无真相。我是专门写爬虫的,所以json格式不了解,我提供一个思路给楼主。我们都知道python有requests库和scrapy爬虫框架,但是它们都有一个缺点,就是速度比较慢,得requests一千次,scrapy一万次。如果你确实想速度快,比如python3。那你请直接爬http,采集你要的数据,然后直接解析,json也好javajson也好。

当然json存储也是个问题,解析速度很慢的。python2直接这么干肯定是慢的,为什么,因为现有python框架都是支持字典的对象的,python3里则换成extensional,所以。不要在爬虫里用中的requests库(这个我不确定python3是不是不支持了)另外scrapy主要是用来做简单的爬虫,而且爬的时候尽量还是尽量减少数据库接触,目的是一定程度上避免很多字典对象的乱写,我们的目的是提高网站体验,也是为了提高数据的有效性,一定程度上加快刷新速度。

scrapy如果想使用其强大的requests库里的reqrequest模块,对象a和b是必须的。而且要注意检查日志记录。其它的什么flaskbottlebiovescrapyworking这些所有其它的框架都可以采用。如果这些在requestsscrapy下不如上面那些而花哨,请慎重对待。有时候后端会要求爬虫使用parse模块,你应该也不是为了爬虫而设计的。 查看全部

文章采集接口啊,你的商品页面里面的都是扯淡

文章采集接口啊,你的商品页面里面只要有采集的数据,就可以把它采下来放在那个接口里面,之后你只要发布商品就能获取到返回的json数据了,都是一些数据文件啊。

btn.json->content.jsonctx.get->json

urllib相关文档1.pythonbuildthewebfromjavascriptcode优先级为52.urllib库的attributeerror处理3.ftp工具-python脚本开发。

楼上的都是扯淡,

我来两个国内比较出名的,酷站众测-python/电脑爬虫,普通版,量大。pypi.io-python/。国外,猪八戒网。

四个字

随便写一个爬虫程序,导出你需要的json,然后用numpy\pandas\scrapy这些数据分析库,把数据处理好放上去,或者用json.loads()把格式化好的数据写到flask的sina.json文件里。至于商品那个问题,你想怎么调怎么调。

最近才写了一个爬虫,天猫,也是做数据分析和爬虫的,

无图无真相。我是专门写爬虫的,所以json格式不了解,我提供一个思路给楼主。我们都知道python有requests库和scrapy爬虫框架,但是它们都有一个缺点,就是速度比较慢,得requests一千次,scrapy一万次。如果你确实想速度快,比如python3。那你请直接爬http,采集你要的数据,然后直接解析,json也好javajson也好。

当然json存储也是个问题,解析速度很慢的。python2直接这么干肯定是慢的,为什么,因为现有python框架都是支持字典的对象的,python3里则换成extensional,所以。不要在爬虫里用中的requests库(这个我不确定python3是不是不支持了)另外scrapy主要是用来做简单的爬虫,而且爬的时候尽量还是尽量减少数据库接触,目的是一定程度上避免很多字典对象的乱写,我们的目的是提高网站体验,也是为了提高数据的有效性,一定程度上加快刷新速度。

scrapy如果想使用其强大的requests库里的reqrequest模块,对象a和b是必须的。而且要注意检查日志记录。其它的什么flaskbottlebiovescrapyworking这些所有其它的框架都可以采用。如果这些在requestsscrapy下不如上面那些而花哨,请慎重对待。有时候后端会要求爬虫使用parse模块,你应该也不是为了爬虫而设计的。

文章采集接口是你做运营对接对应的数据接口没什么

采集交流 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-07-31 00:00

文章采集接口是你做运营对接对应的数据接口,然后提交和获取数据,你无法直接的在你的服务器中直接获取数据,这是第一,然后它的网站还会有api的接口,第三就是接入api的服务器端也是由机房提供和api服务商对接的,这些资源是机房的话有的是需要收费的,不然没人做,第四就是第三方也有商业的api接口供参考,我做过的一个api大概是2万多吧,如果您有这方面的需求可以跟我联系,我了解一下。

这个需要说明下的,当然这个接口已经公开了,只要是靠谱的,对接不费力,只是需要付一点广告费,不过某宝上面随便找个价格都不会少于1200.建议淘宝当面对接,

可以和我合作,如果您不想开机器,我可以手把手教您使用,我们公司有很多年用外网做营销的经验,给您提供价值您2-5w不等的技术支持,可以试试。

好多渠道都有,都还比较便宜,对接一个好点的营销接口没什么,我一个营销软件接口就300-500,市场价格都不高。

如果网站支持外部链接,自己不动手也能弄个链接出来。推荐一个网站,我们公司只接电商类的站,一千多块钱,学校类的我也有接。

现在有很多软件平台都支持推广电商类外部链接,一千多块钱几十个外部链接接口并不贵,另外他也可以做活动之类的外部链接接入。一些传统网站也可以提供自己平台的外部链接接入。 查看全部

文章采集接口是你做运营对接对应的数据接口没什么

文章采集接口是你做运营对接对应的数据接口,然后提交和获取数据,你无法直接的在你的服务器中直接获取数据,这是第一,然后它的网站还会有api的接口,第三就是接入api的服务器端也是由机房提供和api服务商对接的,这些资源是机房的话有的是需要收费的,不然没人做,第四就是第三方也有商业的api接口供参考,我做过的一个api大概是2万多吧,如果您有这方面的需求可以跟我联系,我了解一下。

这个需要说明下的,当然这个接口已经公开了,只要是靠谱的,对接不费力,只是需要付一点广告费,不过某宝上面随便找个价格都不会少于1200.建议淘宝当面对接,

可以和我合作,如果您不想开机器,我可以手把手教您使用,我们公司有很多年用外网做营销的经验,给您提供价值您2-5w不等的技术支持,可以试试。

好多渠道都有,都还比较便宜,对接一个好点的营销接口没什么,我一个营销软件接口就300-500,市场价格都不高。

如果网站支持外部链接,自己不动手也能弄个链接出来。推荐一个网站,我们公司只接电商类的站,一千多块钱,学校类的我也有接。

现在有很多软件平台都支持推广电商类外部链接,一千多块钱几十个外部链接接口并不贵,另外他也可以做活动之类的外部链接接入。一些传统网站也可以提供自己平台的外部链接接入。

淘宝爬虫采集中小型卖家的商品详情页数据可视化分析

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2022-07-05 01:04

文章采集接口,并且需要文章和采集标题匹配,方法很多,有新浪微博爬虫,淘宝爬虫,采集中小型卖家的商品,一般来说,需要让我们的数据可视化分析商品详情页的数据变化,这是个比较麻烦的事,因为淘宝的产品详情页有百万字,每次都去登陆去查,估计就得php5.5及以上的程序,而且有个问题就是,有些网站可能是上一次销售时候留下的采集链接,那么很容易返回了账号和密码信息,而这个信息被淘宝后台盗用了,导致在淘宝后台上班,这是非常危险的,那么有没有比较便捷的办法呢?其实有很多,我这里用的是threejs+react开发,还可以自定义爬取结构,改变url和文章数量,处理返回链接安全性啥的,实现之后,github链接:,我们来一起搞起来,如下图所示,我们需要获取的是采集该商品在该商品详情页的购买信息,因为商品的信息要填的字段实在太多,直接去百度的txt文档的话,怕看不全,所以采用的是对应的react代码实现。

按照代码总共分为三步,首先是读取淘宝中小型卖家商品详情页的链接信息(直接下载源码就可以看到,把这个代码,或者引用的excel文件拷贝到浏览器中就可以读取),然后是读取react的代码,再来读取淘宝中小型卖家商品详情页的内容,最后就是写一个采集器,把这个爬取的商品详情页的数据,全部整理为excel表格(可以根据实际需要调整格式)。

先来看下代码:这里要注意,如果数据量比较大,像上图采集不下那么多条数据,基本上就用不了代码,可以用utils文件直接读取数据,获取的过程需要设置字段名,获取的数据也很简单,就是string类型,我设置了他们的元素样式。因为数据比较多,我就保存在了axios中,方便以后自动处理。而关于爬取逻辑,基本就是根据我们接口查询该商品的历史销售数据来做信息筛选,而接口数据是在淘宝api中获取的,那么我们就可以根据淘宝api获取的历史购买数据,获取淘宝中小型卖家的历史销售信息,以及数据的差异变化来匹配信息,我就拿出以前写过的代码用threejs开发。

具体代码可以直接去github下载,axios中使用代码整理的api链接,如下:,其实现的这个爬取淘宝中小型卖家商品详情页详情页信息的代码,和那个淘宝店铺商品数据筛选的差不多,区别是我们除了针对中小型卖家,还做了扩展出来,方便我们以后数据的下载或者分析。然后我们采用我刚才写的代码,循环爬取中小型卖家商品信息,每个商品就获取10个数据,然后来分析数据页和dom的变化关系,获取全部数据后,通过时间来筛选最终dom中的内容即可,这样,无论最终是否下载这个数据,都是可以。 查看全部

淘宝爬虫采集中小型卖家的商品详情页数据可视化分析

文章采集接口,并且需要文章和采集标题匹配,方法很多,有新浪微博爬虫,淘宝爬虫,采集中小型卖家的商品,一般来说,需要让我们的数据可视化分析商品详情页的数据变化,这是个比较麻烦的事,因为淘宝的产品详情页有百万字,每次都去登陆去查,估计就得php5.5及以上的程序,而且有个问题就是,有些网站可能是上一次销售时候留下的采集链接,那么很容易返回了账号和密码信息,而这个信息被淘宝后台盗用了,导致在淘宝后台上班,这是非常危险的,那么有没有比较便捷的办法呢?其实有很多,我这里用的是threejs+react开发,还可以自定义爬取结构,改变url和文章数量,处理返回链接安全性啥的,实现之后,github链接:,我们来一起搞起来,如下图所示,我们需要获取的是采集该商品在该商品详情页的购买信息,因为商品的信息要填的字段实在太多,直接去百度的txt文档的话,怕看不全,所以采用的是对应的react代码实现。

按照代码总共分为三步,首先是读取淘宝中小型卖家商品详情页的链接信息(直接下载源码就可以看到,把这个代码,或者引用的excel文件拷贝到浏览器中就可以读取),然后是读取react的代码,再来读取淘宝中小型卖家商品详情页的内容,最后就是写一个采集器,把这个爬取的商品详情页的数据,全部整理为excel表格(可以根据实际需要调整格式)。

先来看下代码:这里要注意,如果数据量比较大,像上图采集不下那么多条数据,基本上就用不了代码,可以用utils文件直接读取数据,获取的过程需要设置字段名,获取的数据也很简单,就是string类型,我设置了他们的元素样式。因为数据比较多,我就保存在了axios中,方便以后自动处理。而关于爬取逻辑,基本就是根据我们接口查询该商品的历史销售数据来做信息筛选,而接口数据是在淘宝api中获取的,那么我们就可以根据淘宝api获取的历史购买数据,获取淘宝中小型卖家的历史销售信息,以及数据的差异变化来匹配信息,我就拿出以前写过的代码用threejs开发。

具体代码可以直接去github下载,axios中使用代码整理的api链接,如下:,其实现的这个爬取淘宝中小型卖家商品详情页详情页信息的代码,和那个淘宝店铺商品数据筛选的差不多,区别是我们除了针对中小型卖家,还做了扩展出来,方便我们以后数据的下载或者分析。然后我们采用我刚才写的代码,循环爬取中小型卖家商品信息,每个商品就获取10个数据,然后来分析数据页和dom的变化关系,获取全部数据后,通过时间来筛选最终dom中的内容即可,这样,无论最终是否下载这个数据,都是可以。

简历写着熟悉 Dubbo,居然连 Dubbo 线程池监控都不知道?

采集交流 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-07-03 23:26

Dubbo 是一款优秀的微服务框架,它以其高性能、简单易用、易扩展等特点,广泛应用于互联网、金融保险、科技公司、制造业、零售物流等多个领域。如今,Dubbo 框架已经成了互联网开发中比较常用的技术框架。

在Dubbo框架中,当客户端调用服务端的时候,请求抵达了服务端之后,会有专门的线程池去接收参数并且处理。所以如果要实现Dubbo的线程池监控,就需要先了解下Dubbo底层对于业务线程池的实现原理。

Dubbo底层对于线程池的查看

这里我所使用的框架是 Dubbo 2.7.8 版本,它在底层对于线程池的管理是通过一个叫做ExecutorRepository 的类处理的,这个类负责创建并管理 Dubbo 中的线程池,通过该扩展接口,我们可以获取到Dubbo再实际运行中的业务线程池对象。

具体的处理逻辑部分如下所示:

package org.idea.dubbo.monitor.core.collect;<br />import org.apache.dubbo.common.extension.ExtensionLoader;<br />import org.apache.dubbo.common.threadpool.manager.DefaultExecutorRepository;<br />import org.apache.dubbo.common.threadpool.manager.ExecutorRepository;<br />import java.lang.reflect.Field;<br />import java.util.concurrent.ConcurrentMap;<br />import java.util.concurrent.ExecutorService;<br />import java.util.concurrent.ThreadPoolExecutor;<br />/**<br /> * @Author idea<br /> * @Date created in 7:04 下午 2022/6/29<br /> */<br />public class DubboThreadPoolCollector {<br /> /**<br /> * 获取Dubbo的线程池<br /> * @return<br /> */<br /> public static ThreadPoolExecutor getDubboThreadPoolInfo(){<br /> //dubbo线程池数量监控<br /> try {<br /> ExtensionLoader executorRepositoryExtensionLoader = ExtensionLoader.getExtensionLoader(ExecutorRepository.class);<br /> DefaultExecutorRepository defaultExecutorRepository = (DefaultExecutorRepository) executorRepositoryExtensionLoader.getDefaultExtension();<br /> Field dataField = defaultExecutorRepository.getClass().getDeclaredField("data");<br /> dataField.setAccessible(true);<br /> ConcurrentMap data = (ConcurrentMap) dataField.get(defaultExecutorRepository);<br /> ConcurrentMap executorServiceConcurrentMap = data.get("java.util.concurrent.ExecutorService");<br /> //获取到默认的线程池模型<br /> ThreadPoolExecutor threadPoolExecutor = (ThreadPoolExecutor) executorServiceConcurrentMap.get(9090);<br /> return threadPoolExecutor;<br /> } catch (Exception e) {<br /> e.printStackTrace();<br /> }<br /> return null;<br /> }<br />}

好了,现在我们知道如何在代码中实时查看Dubbo线程池的信息了,那么接下来要做的就是如何采集这些线程池的数据,并且进行上报,最后将上报存储的数据通过统计图的方式展示出来。

下边我们按照采集,上报,展示三个环节来展示数据。

采集数据

在采集数据这块,有两种思路去采集,分别如下:

采用两种不同的模式采集出来的数据,可能会有些差异,下边是两种方式的比对:

统计方式实现难度可能存在的问题

定时任务采集数据

简单

定时任务执行间隙中的数据无法采集,导致数据失真。

请求抵达是采集数据

稍为复杂一些

在每次请求的时候都需要采集数据,会对性能有一定损耗。

通过对实际的业务场景分析,其实第二种方式对应用的性能损耗极微,甚至可以忽略,所以使用这种方式去采集数据的话会比较合适。

下边让我们一起来看看这种方式采集数据的话,该如何实现。

首先我们需要自己定义一个filter过滤器:

package org.idea.dubbo.monitor.core.filter;<br />import org.apache.dubbo.common.constants.CommonConstants;<br />import org.apache.dubbo.common.extension.Activate;<br />import org.apache.dubbo.rpc.*;<br />import org.idea.dubbo.monitor.core.DubboMonitorHandler;<br />import java.util.concurrent.ThreadPoolExecutor;<br />import static org.idea.dubbo.monitor.core.config.CommonCache.DUBBO_INFO_STORE_CENTER;<br />/**<br /> * @Author idea<br /> * @Date created in 2:33 下午 2022/7/1<br /> */<br />@Activate(group = CommonConstants.PROVIDER)<br />public class DubboRecordFilter implements Filter {<br /> @Override<br /> public Result invoke(Invoker invoker, Invocation invocation) throws RpcException {<br /> ThreadPoolExecutor threadPoolExecutor = DubboMonitorHandler.getDubboThreadPoolInfo();<br /> //请求的时候趣统计线程池,当请求量太小的时候,这块的数据可能不准确,但是如果请求量大的话,就接近准确了<br /> DUBBO_INFO_STORE_CENTER.reportInfo(9090,threadPoolExecutor.getActiveCount(),threadPoolExecutor.getQueue().size());<br /> return invoker.invoke(invocation);<br /> }<br />}<br />

关于DUBBO_INFO_STORE_CENTER的代码如下所示:

并且在dubbo的spi配置文件中指定好它们:

dubboRecordFilter=org.idea.dubbo.monitor.core.filter.DubboRecordFilter<br />

当provider加入了这个过滤器以后,若有请求抵达服务端,则会通过这个filter触发采集操作。