抓取网页数据违法吗

抓取网页数据违法吗( 讲讲如何抓取网页表格里的数据(1)_1. )

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-02-05 22:22

讲讲如何抓取网页表格里的数据(1)_1.

)

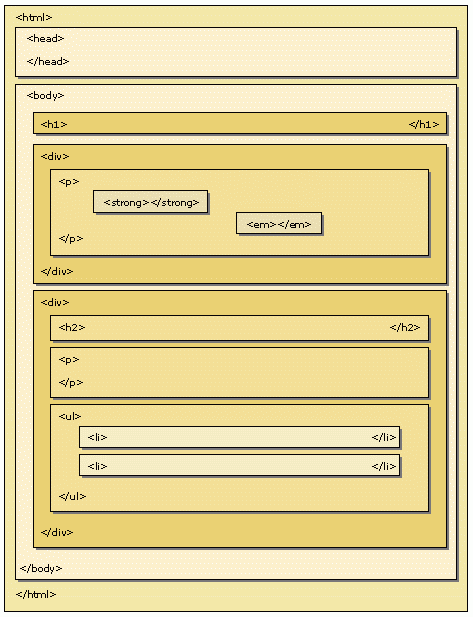

今天我们将讨论如何在 Web 表单中捕获数据。首先我们来分析一下网页中的经典表格是如何组成的。

经典的表格都是关于这些知识点的,没了。让我们编写一个简单的表单 Web Scraper 爬虫。

1.创建站点地图

我们今天的练习 网站 是

%C9%CF%BA%A3&txt道达=%B1%B1%BE%A9

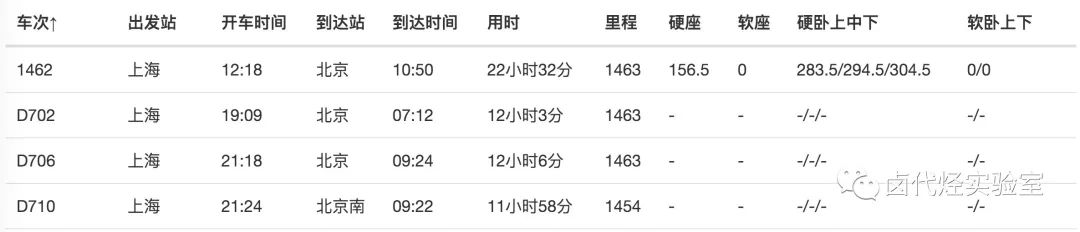

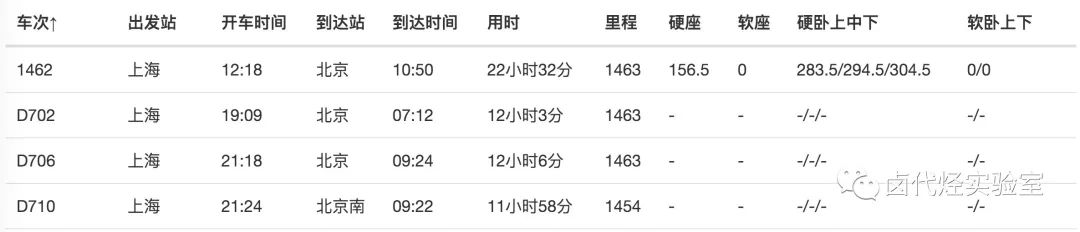

爬虫的内容是爬取上海到北京的所有火车时刻表。

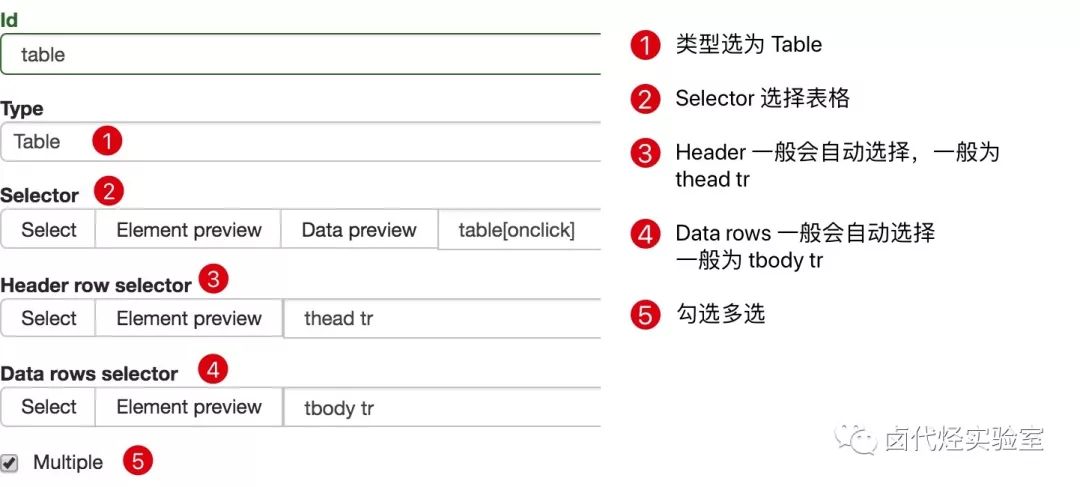

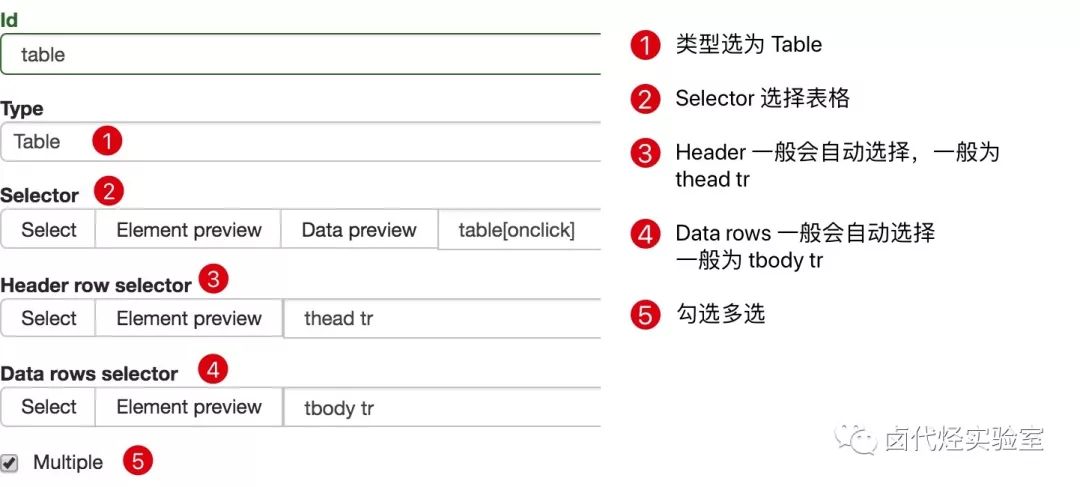

我们首先创建一个收录整个表格的容器,并将Type选择为Table,表示我们要抓取表格。

具体参数如上图所示,因为比较简单,就不多说了。

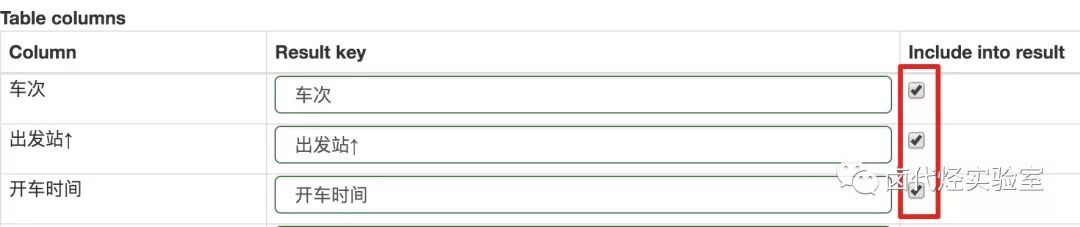

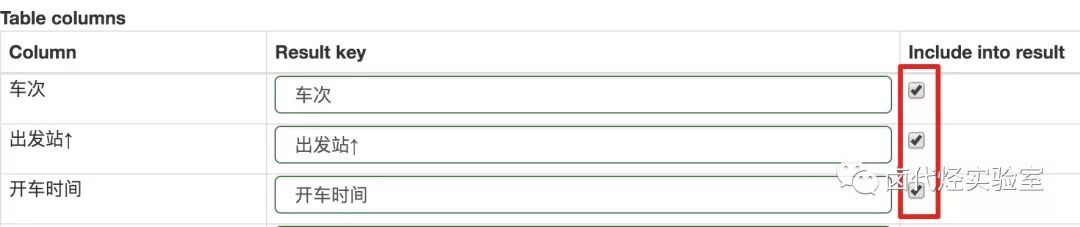

在此面板下向下滚动,您会发现一个不同的面板。如果你看一下,你会发现这些数据实际上是表数据类型的分类。在这种情况下,他列出了火车、出发站和行驶时间的类别。

在表格列类别中,默认勾选每行内容旁边的选择按钮,这意味着默认捕获这些列的内容。如果您不想爬取某种类型的内容,只需去掉相应的复选框即可。

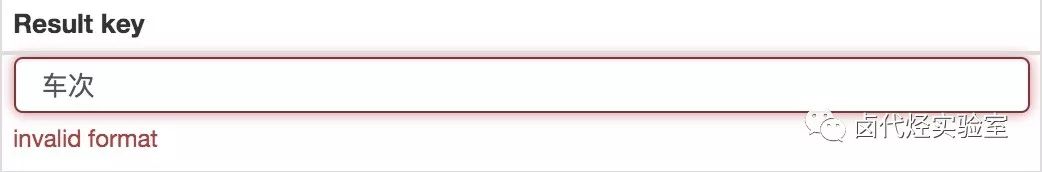

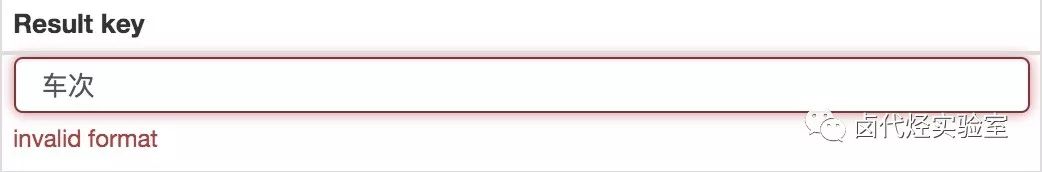

当你点击保存选择器按钮的时候,你会发现Result键的一些选项报错,说invalid format format无效:

解决这个错误非常简单。一般来说,Result 键名的长度是不够的。您可以添加空格和标点符号。如果仍然出现错误,请尝试更改为英文名称:

解决错误并保存成功后,我们就可以按照Web Scraper的爬取例程抓取数据了。

2.我为什么不建议你使用 Web Scraper 的表格选择器?

如果按照刚才的教程,感觉会很流畅,但是看数据的时候,就傻眼了。

刚开始爬的时候,我们先用Data preview预览数据,发现数据很完美:

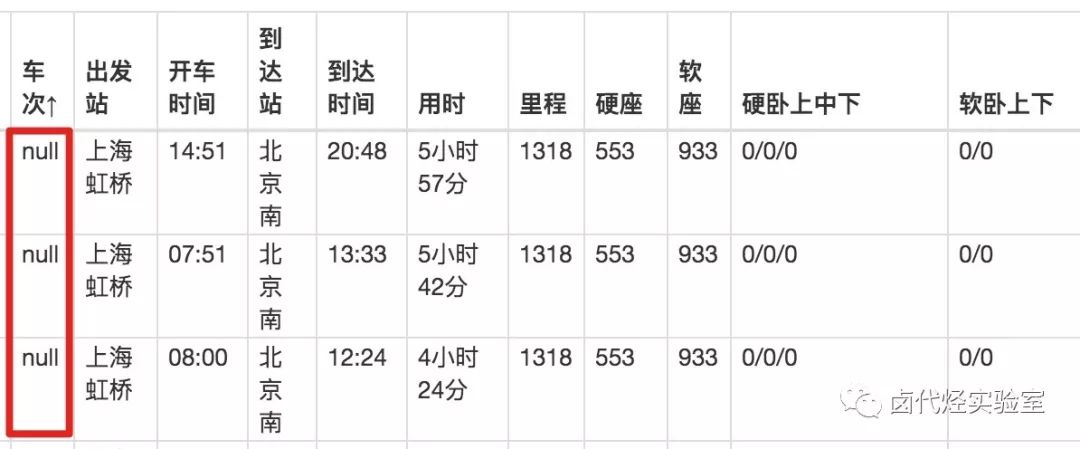

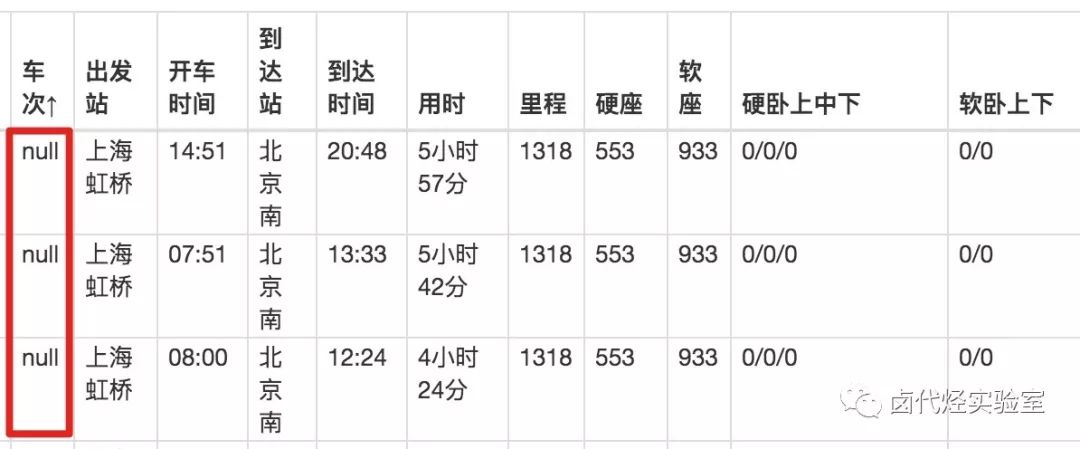

抓取数据后,在浏览器的预览面板中预览,会发现trains一栏的数据为null,表示没有抓取到相关内容:

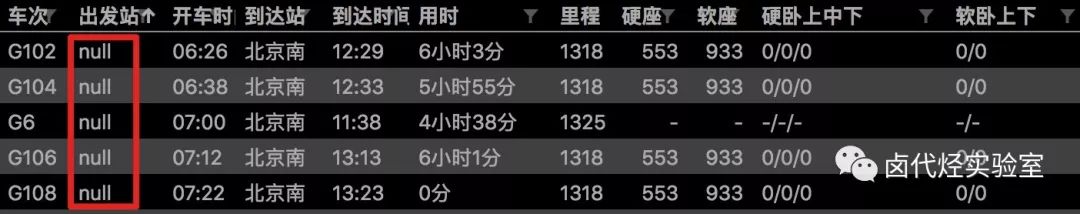

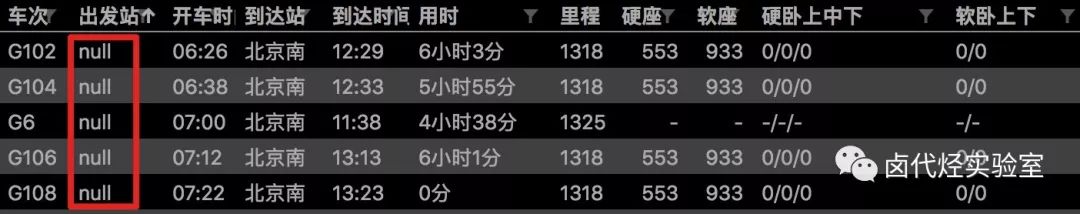

我们下载捕获的CSV文件并在预览器中打开后,我们会发现出现了列车号的数据,但是出发站的数据又为空了!

这不是傻子!

我已经研究这个问题很长时间了。应该是Web Scraper对中文关键词索引的支持不是很友好,所以会抛出一些奇怪的bug,所以不建议大家使用它的Table功能。

如果真的要抓取表数据,可以使用前面的方案,先创建一个Element类型的容器,然后在容器中手动创建一个子选择器,这样就可以避免这个问题了。

以上只是一个原因,另一个原因是,在现代 网站 中,很少有人再使用 HTML 原创表格了。

HTML 为表格提供了基本的标签,例如

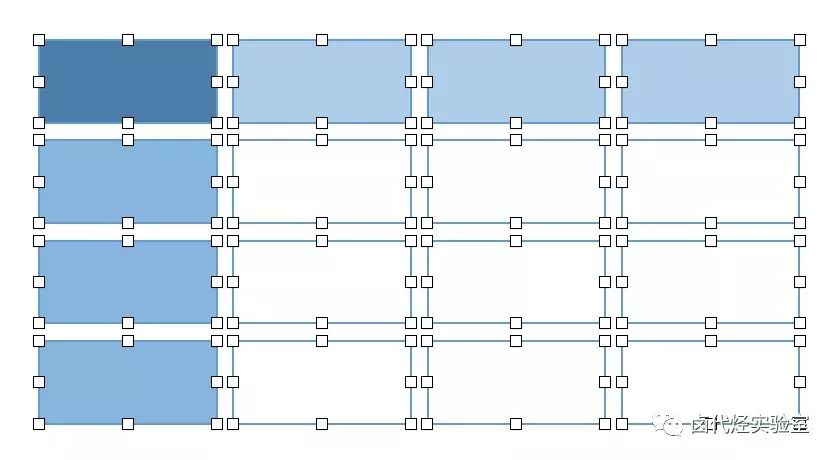

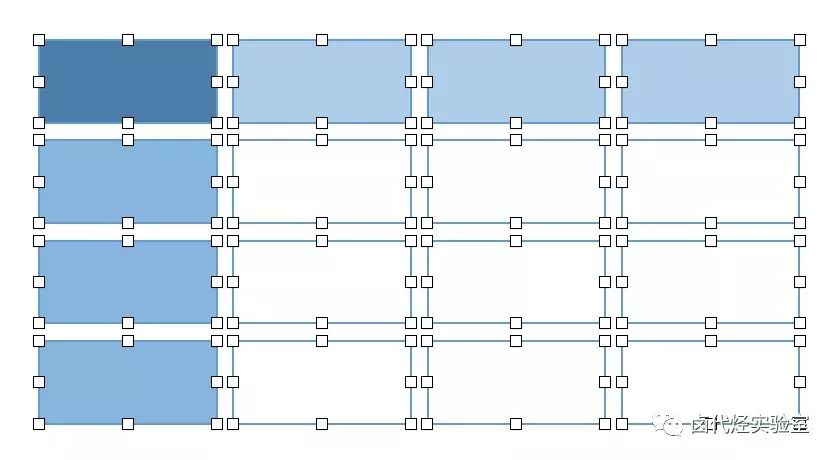

, , 等标签,提供默认样式。优点是互联网刚开发的时候,可以提供开箱即用的形式;缺点是样式过于简单,不易定制。后来很多网站用其他标签来模拟表格,就像PPT用各种大小的块组合成一个表格,很容易自定义:

正因如此,当你使用Table Selector匹配一个表格的时候,可能会匹配不上,因为从Web Scraper的角度来看,你看到的表格是高仿的,根本不是原装的,自然不是。认可。

3.总结

我们不建议直接使用 Web Scraper 的 Table Selector,因为它对中文支持不是很友好,也不太适合现代网页。如果有抢表的需求,可以使用之前创建父子选择器的方法来做。

在之前的文章文章中,我们介绍了Web Scraper对各种翻页的解决方案,比如修改网页链接加载数据、点击“更多按钮”加载数据、下拉自动加载数据等。今天我们讲一种比较常见的翻页方式——pager。

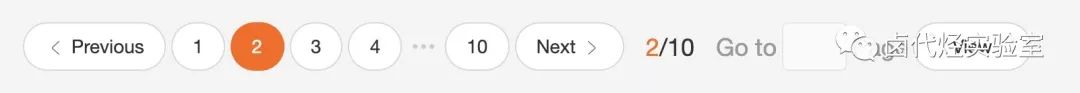

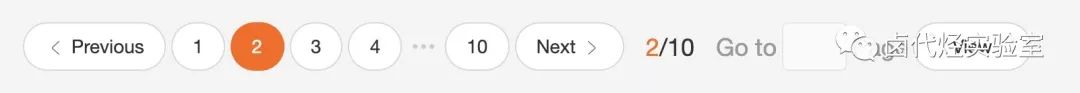

我本来想解释什么是寻呼机,但是我发现浏览一堆定义很麻烦。大家上网已经不是第一年了,看图就知道了。我找到了一个功能齐全的例子,支持数字页码调整,上一页到下一页和指定页数跳转。

今天我们将学习 Web Scraper 如何处理这种类型的翻页。

其实在本教程的第一个例子中,我们就抢到了豆瓣电影TOP排行榜。这个豆瓣电影列表使用寻呼机来划分数据:

但是当时我们是在找网页链接定期爬取,并没有使用pager来爬取。因为当一个网页的链接有规律的变化时,控制链接参数的爬取成本是最低的;如果可以翻页,但是链接的变化不规律,就得去pager了一会儿。

说这些理论有点无聊,我们举个不规则翻页链接的例子。

8月2日是蔡徐坤的生日。为了庆祝,微博上的粉丝给了坤坤300W的转发。微博的转发恰好是被寻呼机分割的,所以我们来分析一下微博的转发。信息页面,了解如何使用 Web Scraper 抓取此类数据。

这条微博的直接链接是:

看了这么多他的视频,为了表达我们的感激之情,我们可以点进去给坤坤加个阅读量。

首先我们看第1页转发的链接,长这样:

第二页是这样的,我注意到有一个额外的#_rnd36 参数:

#_rnd36

第三页参数为#_rnd39

#_rnd39

第 4 页参数是#_rnd76:

#_rnd76

多看几个链接,会发现这个转发页面的URL没有规则,只能通过pager加载数据。让我们开始我们的实践教学课程。

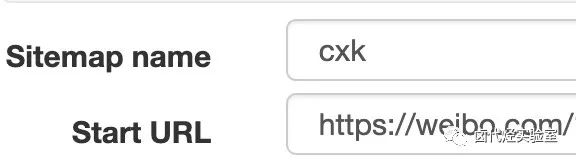

1.创建站点地图

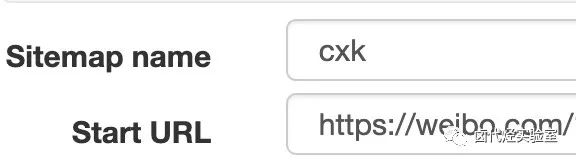

我们首先创建一个SiteMap,这次命名为cxk,起始链接为

2.为容器创建一个选择器

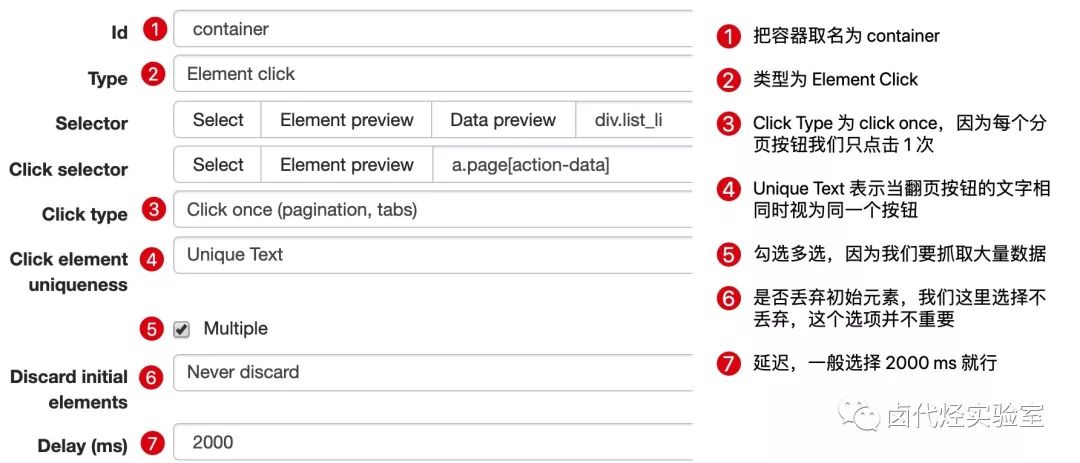

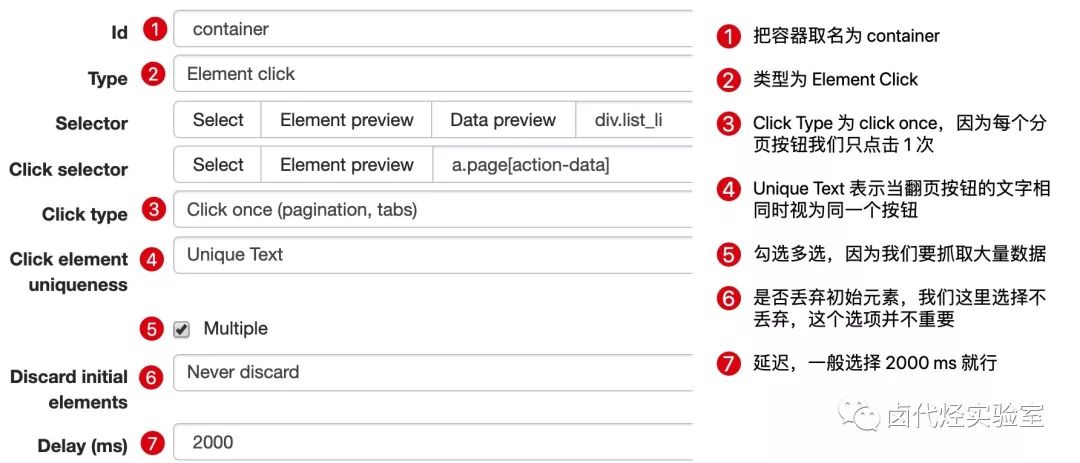

因为我们要点击pager,所以我们选择外层容器的类型为Element Click。具体参数说明见下图。我们之前在《简单数据分析08》中详细讲解过,这里就不多说了。

容器的预览如下图所示:

寻呼机选择过程如下图所示:

3.创建子选择器

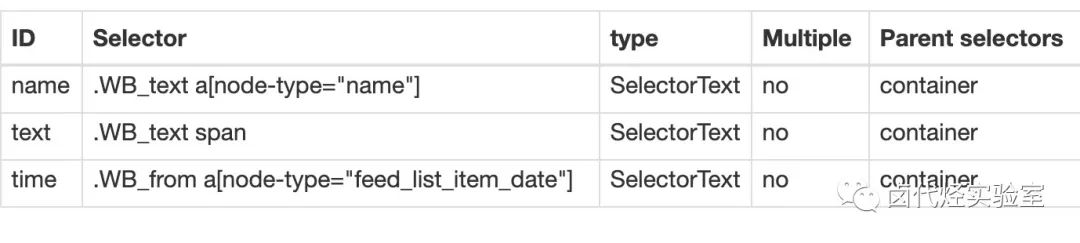

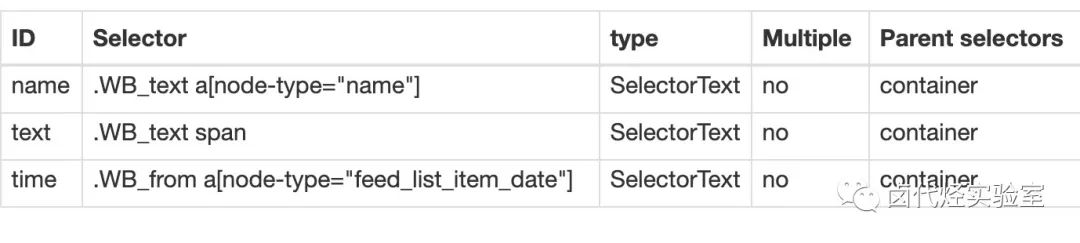

这些子选择器比较简单,类型都是文本选择器。我们选择了三种类型的内容:评论用户名、评论内容和评论时间。

4.捕获数据

可以根据Sitemap cxk -> Scrape 的操作路径抓取数据。

5.一些问题

如果你看了我上面的教程,马上爬数据,你可能遇到的第一个问题就是,300w的数据,我需要一直爬下去吗?

听起来很不现实。毕竟Web Scraper针对的数据量比较少,上万的数据算太多了。不管数据有多大,都要考虑爬取时间是否过长,数据如何存储,如何处理。网站的反爬系统(比如突然弹出一个验证码,这个Web Scraper无能为力)。

考虑到这个问题,如果你看过上一篇关于自动控制抓取次数的教程,你可能会想到使用 :nth-of-type(-n+N) 来控制 N 条数据的抓取。如果你尝试一下,你会发现这个方法根本行不通。

失败的原因其实涉及到一点网页知识。如果您有兴趣,可以阅读下面的说明。不感兴趣的可以直接看最后的结论。

就像我之前介绍的更多加载网页和下拉加载网页一样,它们新加载的数据是附加到当前页面的。你不断向下滚动,数据不断加载,网页的滚动条会越来越短。表示所有数据都在同一页面上。

当我们使用:nth-of-type(-n+N) 来控制加载次数的时候,其实就相当于在这个网页上设置了一个计数器。当数据已经累积到我们想要的数量时,它就会停止爬取。

但是对于使用分页器的网页,每翻一页就相当于刷新当前网页,这样每次都会设置一个计数器。

比如你要抓1000条数据,但是第一页只有20条数据,抓到最后一条,还有980条数据。对于一条数据,还有980,一翻页计数器就清零,又变成1000了……所以这种控制数的方法是无效的。

所以结论是,如果一个pager类的网页想要提前结束爬取,唯一的办法就是断网。当然,如果您有更好的解决方案,可以在评论中回复我,我们可以互相讨论。

6.总结

Pager 是一种非常常见的网页分页方法。我们可以通过 Web Scraper 中的 Element click 处理此类网页,并通过断开网络来结束爬取。

●简单的数据分析(六):Web Scraper翻页-抓取“滚动加载”类型的网页

●简单数据分析(二):Web Scraper尝鲜,抢豆瓣高分电影

●简单的数据分析(一):起源,了解Web Scraper和浏览器技巧

·结尾·

图克社区

采集精彩的免费实用教程

查看全部

抓取网页数据违法吗(

讲讲如何抓取网页表格里的数据(1)_1.

)

今天我们将讨论如何在 Web 表单中捕获数据。首先我们来分析一下网页中的经典表格是如何组成的。

经典的表格都是关于这些知识点的,没了。让我们编写一个简单的表单 Web Scraper 爬虫。

1.创建站点地图

我们今天的练习 网站 是

%C9%CF%BA%A3&txt道达=%B1%B1%BE%A9

爬虫的内容是爬取上海到北京的所有火车时刻表。

我们首先创建一个收录整个表格的容器,并将Type选择为Table,表示我们要抓取表格。

具体参数如上图所示,因为比较简单,就不多说了。

在此面板下向下滚动,您会发现一个不同的面板。如果你看一下,你会发现这些数据实际上是表数据类型的分类。在这种情况下,他列出了火车、出发站和行驶时间的类别。

在表格列类别中,默认勾选每行内容旁边的选择按钮,这意味着默认捕获这些列的内容。如果您不想爬取某种类型的内容,只需去掉相应的复选框即可。

当你点击保存选择器按钮的时候,你会发现Result键的一些选项报错,说invalid format format无效:

解决这个错误非常简单。一般来说,Result 键名的长度是不够的。您可以添加空格和标点符号。如果仍然出现错误,请尝试更改为英文名称:

解决错误并保存成功后,我们就可以按照Web Scraper的爬取例程抓取数据了。

2.我为什么不建议你使用 Web Scraper 的表格选择器?

如果按照刚才的教程,感觉会很流畅,但是看数据的时候,就傻眼了。

刚开始爬的时候,我们先用Data preview预览数据,发现数据很完美:

抓取数据后,在浏览器的预览面板中预览,会发现trains一栏的数据为null,表示没有抓取到相关内容:

我们下载捕获的CSV文件并在预览器中打开后,我们会发现出现了列车号的数据,但是出发站的数据又为空了!

这不是傻子!

我已经研究这个问题很长时间了。应该是Web Scraper对中文关键词索引的支持不是很友好,所以会抛出一些奇怪的bug,所以不建议大家使用它的Table功能。

如果真的要抓取表数据,可以使用前面的方案,先创建一个Element类型的容器,然后在容器中手动创建一个子选择器,这样就可以避免这个问题了。

以上只是一个原因,另一个原因是,在现代 网站 中,很少有人再使用 HTML 原创表格了。

HTML 为表格提供了基本的标签,例如

, , 等标签,提供默认样式。优点是互联网刚开发的时候,可以提供开箱即用的形式;缺点是样式过于简单,不易定制。后来很多网站用其他标签来模拟表格,就像PPT用各种大小的块组合成一个表格,很容易自定义:

正因如此,当你使用Table Selector匹配一个表格的时候,可能会匹配不上,因为从Web Scraper的角度来看,你看到的表格是高仿的,根本不是原装的,自然不是。认可。

3.总结

我们不建议直接使用 Web Scraper 的 Table Selector,因为它对中文支持不是很友好,也不太适合现代网页。如果有抢表的需求,可以使用之前创建父子选择器的方法来做。

在之前的文章文章中,我们介绍了Web Scraper对各种翻页的解决方案,比如修改网页链接加载数据、点击“更多按钮”加载数据、下拉自动加载数据等。今天我们讲一种比较常见的翻页方式——pager。

我本来想解释什么是寻呼机,但是我发现浏览一堆定义很麻烦。大家上网已经不是第一年了,看图就知道了。我找到了一个功能齐全的例子,支持数字页码调整,上一页到下一页和指定页数跳转。

今天我们将学习 Web Scraper 如何处理这种类型的翻页。

其实在本教程的第一个例子中,我们就抢到了豆瓣电影TOP排行榜。这个豆瓣电影列表使用寻呼机来划分数据:

但是当时我们是在找网页链接定期爬取,并没有使用pager来爬取。因为当一个网页的链接有规律的变化时,控制链接参数的爬取成本是最低的;如果可以翻页,但是链接的变化不规律,就得去pager了一会儿。

说这些理论有点无聊,我们举个不规则翻页链接的例子。

8月2日是蔡徐坤的生日。为了庆祝,微博上的粉丝给了坤坤300W的转发。微博的转发恰好是被寻呼机分割的,所以我们来分析一下微博的转发。信息页面,了解如何使用 Web Scraper 抓取此类数据。

这条微博的直接链接是:

看了这么多他的视频,为了表达我们的感激之情,我们可以点进去给坤坤加个阅读量。

首先我们看第1页转发的链接,长这样:

第二页是这样的,我注意到有一个额外的#_rnd36 参数:

#_rnd36

第三页参数为#_rnd39

#_rnd39

第 4 页参数是#_rnd76:

#_rnd76

多看几个链接,会发现这个转发页面的URL没有规则,只能通过pager加载数据。让我们开始我们的实践教学课程。

1.创建站点地图

我们首先创建一个SiteMap,这次命名为cxk,起始链接为

2.为容器创建一个选择器

因为我们要点击pager,所以我们选择外层容器的类型为Element Click。具体参数说明见下图。我们之前在《简单数据分析08》中详细讲解过,这里就不多说了。

容器的预览如下图所示:

寻呼机选择过程如下图所示:

3.创建子选择器

这些子选择器比较简单,类型都是文本选择器。我们选择了三种类型的内容:评论用户名、评论内容和评论时间。

4.捕获数据

可以根据Sitemap cxk -> Scrape 的操作路径抓取数据。

5.一些问题

如果你看了我上面的教程,马上爬数据,你可能遇到的第一个问题就是,300w的数据,我需要一直爬下去吗?

听起来很不现实。毕竟Web Scraper针对的数据量比较少,上万的数据算太多了。不管数据有多大,都要考虑爬取时间是否过长,数据如何存储,如何处理。网站的反爬系统(比如突然弹出一个验证码,这个Web Scraper无能为力)。

考虑到这个问题,如果你看过上一篇关于自动控制抓取次数的教程,你可能会想到使用 :nth-of-type(-n+N) 来控制 N 条数据的抓取。如果你尝试一下,你会发现这个方法根本行不通。

失败的原因其实涉及到一点网页知识。如果您有兴趣,可以阅读下面的说明。不感兴趣的可以直接看最后的结论。

就像我之前介绍的更多加载网页和下拉加载网页一样,它们新加载的数据是附加到当前页面的。你不断向下滚动,数据不断加载,网页的滚动条会越来越短。表示所有数据都在同一页面上。

当我们使用:nth-of-type(-n+N) 来控制加载次数的时候,其实就相当于在这个网页上设置了一个计数器。当数据已经累积到我们想要的数量时,它就会停止爬取。

但是对于使用分页器的网页,每翻一页就相当于刷新当前网页,这样每次都会设置一个计数器。

比如你要抓1000条数据,但是第一页只有20条数据,抓到最后一条,还有980条数据。对于一条数据,还有980,一翻页计数器就清零,又变成1000了……所以这种控制数的方法是无效的。

所以结论是,如果一个pager类的网页想要提前结束爬取,唯一的办法就是断网。当然,如果您有更好的解决方案,可以在评论中回复我,我们可以互相讨论。

6.总结

Pager 是一种非常常见的网页分页方法。我们可以通过 Web Scraper 中的 Element click 处理此类网页,并通过断开网络来结束爬取。

●简单的数据分析(六):Web Scraper翻页-抓取“滚动加载”类型的网页

●简单数据分析(二):Web Scraper尝鲜,抢豆瓣高分电影

●简单的数据分析(一):起源,了解Web Scraper和浏览器技巧

·结尾·

图克社区

采集精彩的免费实用教程

抓取网页数据违法吗(网络爬虫(webcrawler)网页分析算法())

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2022-02-04 17:01

网络爬虫的网页分析算法如下:

网页分析算法可以分为三类:基于网络拓扑、基于网页内容和基于用户访问行为。

拓扑分析算法

基于网页之间的链接,通过已知的网页或数据,评估与其有直接或间接链接关系的对象(可以是网页或网站等)的算法。进一步分为三种:网页粒度、网站粒度和网页块粒度。

1 网页粒度分析算法

PageRank 和 HITS 算法是最常见的链接分析算法。两者都是通过网页间链接度的递归归一化计算得到每个网页的重要性。PageRank算法虽然考虑了用户访问行为的随机性和Sink网页的存在性,但忽略了大部分用户访问的目的性,即网页和查询主题链接的相关性。针对这个问题,HITS算法提出了两个关键概念:权威和枢纽。

基于链接的爬取问题是相关页面的主题组之间的隧道现象,即爬取路径上很多离题的页面也指向目标页面,局部评价策略中断了爬取行为当前路径。参考文献[21]提出了一种基于反向链接的层次上下文模型(Context Model),用于将指向一定物理跳半径内的目标网页的网页拓扑图的中心Layer0描述为目标网页。网页根据指向目标网页的物理跳数进行层次划分,外层网页到内层网页的链接称为反向链接。

2 网站粒度分析算法

网站粒度资源发现和管理策略也比网页粒度更简单有效。网站粒度爬取的关键是站点的划分和SiteRank的计算。SiteRank的计算方法与PageRank类似,但需要对网站之间的链接进行一定程度的抽象,并在一定模型下计算链接的权重。

网站划分分为两种:按域名划分和按IP地址划分。参考文献[18]讨论了分布式情况下,通过划分同一域名下不同主机和服务器的IP地址,构建站点地图,并采用类似于PageRank的方法评估SiteRank。同时,根据每个站点不同文件的分布情况,构建文档图,结合SiteRank分布式计算得到DocRank。参考文献[18]证明,使用分布式SiteRank计算不仅大大降低了单个站点的算法成本,而且克服了单个站点对全网覆盖范围有限的缺点。一个额外的好处是,常见的 PageRank 欺诈很难欺骗 SiteRank。

3 网页块粒度分析算法

一个页面往往收录多个指向其他页面的链接,而这些链接中只有一部分指向与主题相关的网页,或者根据网页的链接锚文本表明其重要性高。但是在PageRank和HITS算法中,这些链接是没有区分的,所以往往会给网页分析带来广告等噪声链接的干扰。页面块级(Block?级)链接分析算法的基本思想是通过VIPS页面切分算法将页面划分为不同的页面块(page blocks),然后创建page?to?block和堵塞?to?page 的链接矩阵,? 分别表示为 Z 和 X。因此,page-to-page图上的page block level的PageRank为?W?p=X×Z;? 块到块图上的 BlockRank 是 ?W?b=Z×X。

网页内容分析算法

基于网页内容的分析算法是指利用网页内容的特征(文本、数据等资源)对网页进行评价。网页的内容已经从基于超文本的内容演变为动态页面(或称为Hidden Web)数据,后者的数据量约为直接可见页面数据(PIW,Publicly Indexable Web)的400~500%。次。另一方面,多媒体数据、Web Service等各种形式的网络资源日益丰富。因此,基于网页内容的分析算法也从原来比较简单的文本检索方法发展到网页数据提取、机器学习、数据挖掘、语义理解等多种方法的综合应用。本节根据网页数据的不同形式,基于网页内容的分析算法分为以下三类:第一类是针对以文本和超链接为主的非结构化或非常简单的网页;第二个是结构化网页。数据源(如RDBMS)动态生成的页面数据不能直接批量访问;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。数据源(如RDBMS)动态生成的页面数据不能直接批量访问;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。数据源(如RDBMS)动态生成的页面数据不能直接批量访问;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。

基于文本的网页分析算法

1) 纯文本分类和聚类算法

它在很大程度上借鉴了文本检索的技术。文本分析算法可以快速有效地对网页进行分类和聚类,但很少单独使用,因为它们忽略了网页之间和网页内的结构信息。

2) 超文本分类和聚类算法

根据网页链接的网页的相关类型对网页进行分类,并通过关联的网页推断网页的类型。 查看全部

抓取网页数据违法吗(网络爬虫(webcrawler)网页分析算法())

网络爬虫的网页分析算法如下:

网页分析算法可以分为三类:基于网络拓扑、基于网页内容和基于用户访问行为。

拓扑分析算法

基于网页之间的链接,通过已知的网页或数据,评估与其有直接或间接链接关系的对象(可以是网页或网站等)的算法。进一步分为三种:网页粒度、网站粒度和网页块粒度。

1 网页粒度分析算法

PageRank 和 HITS 算法是最常见的链接分析算法。两者都是通过网页间链接度的递归归一化计算得到每个网页的重要性。PageRank算法虽然考虑了用户访问行为的随机性和Sink网页的存在性,但忽略了大部分用户访问的目的性,即网页和查询主题链接的相关性。针对这个问题,HITS算法提出了两个关键概念:权威和枢纽。

基于链接的爬取问题是相关页面的主题组之间的隧道现象,即爬取路径上很多离题的页面也指向目标页面,局部评价策略中断了爬取行为当前路径。参考文献[21]提出了一种基于反向链接的层次上下文模型(Context Model),用于将指向一定物理跳半径内的目标网页的网页拓扑图的中心Layer0描述为目标网页。网页根据指向目标网页的物理跳数进行层次划分,外层网页到内层网页的链接称为反向链接。

2 网站粒度分析算法

网站粒度资源发现和管理策略也比网页粒度更简单有效。网站粒度爬取的关键是站点的划分和SiteRank的计算。SiteRank的计算方法与PageRank类似,但需要对网站之间的链接进行一定程度的抽象,并在一定模型下计算链接的权重。

网站划分分为两种:按域名划分和按IP地址划分。参考文献[18]讨论了分布式情况下,通过划分同一域名下不同主机和服务器的IP地址,构建站点地图,并采用类似于PageRank的方法评估SiteRank。同时,根据每个站点不同文件的分布情况,构建文档图,结合SiteRank分布式计算得到DocRank。参考文献[18]证明,使用分布式SiteRank计算不仅大大降低了单个站点的算法成本,而且克服了单个站点对全网覆盖范围有限的缺点。一个额外的好处是,常见的 PageRank 欺诈很难欺骗 SiteRank。

3 网页块粒度分析算法

一个页面往往收录多个指向其他页面的链接,而这些链接中只有一部分指向与主题相关的网页,或者根据网页的链接锚文本表明其重要性高。但是在PageRank和HITS算法中,这些链接是没有区分的,所以往往会给网页分析带来广告等噪声链接的干扰。页面块级(Block?级)链接分析算法的基本思想是通过VIPS页面切分算法将页面划分为不同的页面块(page blocks),然后创建page?to?block和堵塞?to?page 的链接矩阵,? 分别表示为 Z 和 X。因此,page-to-page图上的page block level的PageRank为?W?p=X×Z;? 块到块图上的 BlockRank 是 ?W?b=Z×X。

网页内容分析算法

基于网页内容的分析算法是指利用网页内容的特征(文本、数据等资源)对网页进行评价。网页的内容已经从基于超文本的内容演变为动态页面(或称为Hidden Web)数据,后者的数据量约为直接可见页面数据(PIW,Publicly Indexable Web)的400~500%。次。另一方面,多媒体数据、Web Service等各种形式的网络资源日益丰富。因此,基于网页内容的分析算法也从原来比较简单的文本检索方法发展到网页数据提取、机器学习、数据挖掘、语义理解等多种方法的综合应用。本节根据网页数据的不同形式,基于网页内容的分析算法分为以下三类:第一类是针对以文本和超链接为主的非结构化或非常简单的网页;第二个是结构化网页。数据源(如RDBMS)动态生成的页面数据不能直接批量访问;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。数据源(如RDBMS)动态生成的页面数据不能直接批量访问;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。数据源(如RDBMS)动态生成的页面数据不能直接批量访问;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。

基于文本的网页分析算法

1) 纯文本分类和聚类算法

它在很大程度上借鉴了文本检索的技术。文本分析算法可以快速有效地对网页进行分类和聚类,但很少单独使用,因为它们忽略了网页之间和网页内的结构信息。

2) 超文本分类和聚类算法

根据网页链接的网页的相关类型对网页进行分类,并通过关联的网页推断网页的类型。

抓取网页数据违法吗(Python网络爬虫findfind动态网页的两种技术:1.使用)

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2022-02-02 18:15

由于主流的网站都使用JavaScript来展示网页内容,不像之前简单的静态网页爬取,在使用JavaScript的时候,很多内容并没有出现在HTML源码中,而是放在了HTML中源代码。一段JavaScript代码,最终渲染出来的数据是通过JavaScript提取服务器返回的数据,加载到源代码中进行渲染。因此,用于抓取静态网页的技术可能无法正常工作。因此,我们需要使用两种技术进行动态网页抓取:

1.通过浏览器检查元素解析真实网页地址;

2.一种使用 selenium 模拟浏览器的方法。

我们这里先介绍第一种方法。

以爬取《Python Web爬虫:从入门到实践》一书作者的个人博客评论为例。URL: 1) "capture": 找到真实的数据地址

右键单击“检查”,单击“网络”,然后选择“js”。刷新页面,选择数据列表?callback....页面刷新时返回的js文件。在右侧,再次选择页眉。如图所示:

其中,Request URL 是真实的数据地址。

在此状态下滚动鼠标滚轮以发现 User-Agent。

2)相关代码:

import requests

import json

headers={\'User-Agent\':\'Mozilla/5.0 (Windows NT 6.3; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36\'}

link="https://api-zero.livere.com/v1 ... ot%3B

r=requests.get(link,headers=headers)

# 获取 json 的 string

json_string = r.text

json_string = json_string[json_string.find(\'{\'):-2]

json_data=json.loads(json_string)

comment_list=json_data[\'results\'][\'parents\']

for eachone in comment_list:

message=eachone[\'content\']

print(message)

输出是:

现在死在了4.2节上,页面评论是有的,但是XHR里没有东西啊,这是什么情况?有解决的大神吗?

为何静态网页抓取不了?

奇怪了,我按照书上的方法来操作,XHR也是空的啊

XHR没有显示任何东西啊。奇怪。

找到原因了

caps["marionette"] = True

作者可以解释一下这句话是干什么的吗

我用的是 pycham IDE,按照作者的写法写的,怎么不行

对火狐版本有要求吗

4.3.1 打开Hello World,代码用的作者的,火狐地址我也设置了,为啥运行没反应

from selenium import webdriver

from selenium.webdriver.firefox.firefox_binary import FirefoxBinary

caps = webdriver.DesiredCapabilities().FIREFOX

caps["marionette"] = False

binary = FirefoxBinary(r\'C:\Program Files\Mozilla Firefox\firefox.exe\')

#把上述地址改成你电脑中Firefox程序的地址

driver = webdriver.Firefox(firefox_binary=binary, capabilities=caps)

driver.get("http://www.santostang.com/2017 ... 6quot;)

我是番茄

为什么刷新没有XHR数据,评论明明加载出来了

代码分析:

1) 对于代码 json_string.find() api 解析为:

Docstring:

S.find(sub[, start[, end]]) -> int

Return the lowest index in S where substring sub is found,

such that sub is contained within S[start:end]. Optional

arguments start and end are interpreted as in slice notation.

Return -1 on failure.

Type: method_descriptor

所以代码 json_string.find(\'{\') 返回“{”在 json_string 字符串中的索引位置。

2)如果在代码中加一行代码print json_string,会输出句子(由于输出内容太多,只截取开头和结尾,关键位置用红色标出) :

/**/ typeof jQuery112405600294326674093_1523687034324 === \'function\' && jQuery112405600294326674093_1523687034324({"results":{"parents":[{"replySeq":33365104,"name":"骨犬","memberId":"B9E06FBF9013D49CADBB5B623E8226C8","memberIcon":"http://q.qlogo.cn/qqapp/101256 ... ot%3B,"memberUrl":"https://qq.com/","memberDomain":"qq","good":0,"bad":0,"police":0,"parentSeq":33365104,"directSeq":0,"shortUrl":null,"title":"Hello world! - 数据科学@唐松

Santos","site":"http://www.santostang.com/2017 ... ot%3B,"email":null,"ipAddress":"27.210.192.241","isMobile":"0","agent":"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/47.0.2526.108 Safari/537.36 2345Explorer/8.8.3.16721","septSns":null,"targetService":null,"targetUserName":null,"info1":null,"info2":null,"info3":null,"image1":null,"image2":null,"image3":null,"link1":null,"link2":null,"link3":null,"isSecret":0,"isModified":0,"confirm":0,"subCount":1,"regdate":"2018-01-01T06:27:50.000Z","deletedDate":null,"file1":null,"file2":null,"file3":null,"additionalSeq":0,"content":"现在死在了4.2节上,页面评论是有的,但是XHR里没有东西啊,这是什么情况?有解决的大神吗?"

。。。。。。。。。 tent":"我的也是提示火狐版本不匹配,你解决了吗","quotationSeq":null,"quotationContent":null,"consumerSeq":1020,"livereSeq":28583,"repSeq":3871836,"memberGroupSeq":26828779,"memberSeq":27312353,"status":0,"repGroupSeq":0,"adminSeq":25413747,"deleteReason":null,"sticker":0,"version":null}],"quotations":[]},"resultCode":200,"resultMessage":"Okay, livere"});

从上面的输出,我们可以看出在代码中加入 json_string = json_string[json_string.find(\'{\'):-2] 的重要性。

如果不添加json_string.find(\'{\'),则结果不是合法的json格式,无法成功形成json文件;如果没有截到倒数第二位,则结果收录冗余);它也不构成合法的 json 格式。

3)对于代码comment_list=json_data[\'results\'][\'parents\']和message=eachone[\'content\']中括号内字符串类型的标签定位,可以是发现在上面2)中的关键部分进行了搜索,也就是截取后的合法json文件中同时收录了“results”和“parents”,所以用两个括号逐步定位,又因为我们爬的是评论,它的内容在json文件的“content”标签中,所以使用[“content”]来定位。

观察到实际数据地址中的偏移量是页码。 查看全部

抓取网页数据违法吗(Python网络爬虫findfind动态网页的两种技术:1.使用)

由于主流的网站都使用JavaScript来展示网页内容,不像之前简单的静态网页爬取,在使用JavaScript的时候,很多内容并没有出现在HTML源码中,而是放在了HTML中源代码。一段JavaScript代码,最终渲染出来的数据是通过JavaScript提取服务器返回的数据,加载到源代码中进行渲染。因此,用于抓取静态网页的技术可能无法正常工作。因此,我们需要使用两种技术进行动态网页抓取:

1.通过浏览器检查元素解析真实网页地址;

2.一种使用 selenium 模拟浏览器的方法。

我们这里先介绍第一种方法。

以爬取《Python Web爬虫:从入门到实践》一书作者的个人博客评论为例。URL: 1) "capture": 找到真实的数据地址

右键单击“检查”,单击“网络”,然后选择“js”。刷新页面,选择数据列表?callback....页面刷新时返回的js文件。在右侧,再次选择页眉。如图所示:

其中,Request URL 是真实的数据地址。

在此状态下滚动鼠标滚轮以发现 User-Agent。

2)相关代码:

import requests

import json

headers={\'User-Agent\':\'Mozilla/5.0 (Windows NT 6.3; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36\'}

link="https://api-zero.livere.com/v1 ... ot%3B

r=requests.get(link,headers=headers)

# 获取 json 的 string

json_string = r.text

json_string = json_string[json_string.find(\'{\'):-2]

json_data=json.loads(json_string)

comment_list=json_data[\'results\'][\'parents\']

for eachone in comment_list:

message=eachone[\'content\']

print(message)

输出是:

现在死在了4.2节上,页面评论是有的,但是XHR里没有东西啊,这是什么情况?有解决的大神吗?

为何静态网页抓取不了?

奇怪了,我按照书上的方法来操作,XHR也是空的啊

XHR没有显示任何东西啊。奇怪。

找到原因了

caps["marionette"] = True

作者可以解释一下这句话是干什么的吗

我用的是 pycham IDE,按照作者的写法写的,怎么不行

对火狐版本有要求吗

4.3.1 打开Hello World,代码用的作者的,火狐地址我也设置了,为啥运行没反应

from selenium import webdriver

from selenium.webdriver.firefox.firefox_binary import FirefoxBinary

caps = webdriver.DesiredCapabilities().FIREFOX

caps["marionette"] = False

binary = FirefoxBinary(r\'C:\Program Files\Mozilla Firefox\firefox.exe\')

#把上述地址改成你电脑中Firefox程序的地址

driver = webdriver.Firefox(firefox_binary=binary, capabilities=caps)

driver.get("http://www.santostang.com/2017 ... 6quot;)

我是番茄

为什么刷新没有XHR数据,评论明明加载出来了

代码分析:

1) 对于代码 json_string.find() api 解析为:

Docstring:

S.find(sub[, start[, end]]) -> int

Return the lowest index in S where substring sub is found,

such that sub is contained within S[start:end]. Optional

arguments start and end are interpreted as in slice notation.

Return -1 on failure.

Type: method_descriptor

所以代码 json_string.find(\'{\') 返回“{”在 json_string 字符串中的索引位置。

2)如果在代码中加一行代码print json_string,会输出句子(由于输出内容太多,只截取开头和结尾,关键位置用红色标出) :

/**/ typeof jQuery112405600294326674093_1523687034324 === \'function\' && jQuery112405600294326674093_1523687034324({"results":{"parents":[{"replySeq":33365104,"name":"骨犬","memberId":"B9E06FBF9013D49CADBB5B623E8226C8","memberIcon":"http://q.qlogo.cn/qqapp/101256 ... ot%3B,"memberUrl":"https://qq.com/","memberDomain":"qq","good":0,"bad":0,"police":0,"parentSeq":33365104,"directSeq":0,"shortUrl":null,"title":"Hello world! - 数据科学@唐松

Santos","site":"http://www.santostang.com/2017 ... ot%3B,"email":null,"ipAddress":"27.210.192.241","isMobile":"0","agent":"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/47.0.2526.108 Safari/537.36 2345Explorer/8.8.3.16721","septSns":null,"targetService":null,"targetUserName":null,"info1":null,"info2":null,"info3":null,"image1":null,"image2":null,"image3":null,"link1":null,"link2":null,"link3":null,"isSecret":0,"isModified":0,"confirm":0,"subCount":1,"regdate":"2018-01-01T06:27:50.000Z","deletedDate":null,"file1":null,"file2":null,"file3":null,"additionalSeq":0,"content":"现在死在了4.2节上,页面评论是有的,但是XHR里没有东西啊,这是什么情况?有解决的大神吗?"

。。。。。。。。。 tent":"我的也是提示火狐版本不匹配,你解决了吗","quotationSeq":null,"quotationContent":null,"consumerSeq":1020,"livereSeq":28583,"repSeq":3871836,"memberGroupSeq":26828779,"memberSeq":27312353,"status":0,"repGroupSeq":0,"adminSeq":25413747,"deleteReason":null,"sticker":0,"version":null}],"quotations":[]},"resultCode":200,"resultMessage":"Okay, livere"});

从上面的输出,我们可以看出在代码中加入 json_string = json_string[json_string.find(\'{\'):-2] 的重要性。

如果不添加json_string.find(\'{\'),则结果不是合法的json格式,无法成功形成json文件;如果没有截到倒数第二位,则结果收录冗余);它也不构成合法的 json 格式。

3)对于代码comment_list=json_data[\'results\'][\'parents\']和message=eachone[\'content\']中括号内字符串类型的标签定位,可以是发现在上面2)中的关键部分进行了搜索,也就是截取后的合法json文件中同时收录了“results”和“parents”,所以用两个括号逐步定位,又因为我们爬的是评论,它的内容在json文件的“content”标签中,所以使用[“content”]来定位。

观察到实际数据地址中的偏移量是页码。

抓取网页数据违法吗(网站所有者会为网站设置各种反抓取技术来阻止抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-02-02 18:12

网页抓取是一种经常用于自动化人类浏览行为的技术,以便有效地从网页中检索大量数据。各种网络抓取工具越来越受欢迎,并造福于各个领域的人们。由于过度的网络抓取会使网络服务器过载并导致服务器故障,网站所有者为网站设置了各种反爬虫技术来阻止爬虫,使得网络抓取更加困难。本文将重点介绍如何在不被阻止的情况下持续抓取网页。

1、放慢抓取速度

大多数网络抓取活动旨在尽快获取数据。当人们访问 网站 时,与网页抓取相比,浏览速度要慢得多。因此,网站 通过跟踪您的访问速度很容易将您作为爬虫捕获。因此,您可以在请求之间设置一些随机时间延迟,并减少一次对 1-2 个页面的并发页面访问。

2、,使用代理服务器

当站点检测到来自单个 IP 地址的多个请求时,它可以轻松阻止该 IP 地址。为了避免通过同一个 IP 地址发送所有请求,您可以使用代理服务器,您可以随机使用它们,将您的请求路由到不同的 IP 地址。

3、应用不同的抓取模式

人们通常在随机点击或查看时间浏览 网站,而网页抓取始终遵循与编程机器人遵循特定逻辑相同的抓取模式,反抓取机制可以通过识别在 网站 上执行的重复抓取行为来工作轻松检测爬虫。因此,您需要不时更改抓取模式并结合随机点击、鼠标移动或等待时间,以使网页抓取更加用户友好。

4、蜜罐陷阱

蜜罐是普通访问者看不到的链接,但存在于 HTML 代码中,并且可以被网络爬虫找到。它们就像陷阱,通过将刮板引导到空白页面来检测刮板。一旦特定访问者查看了蜜罐页面,网站 可以相对确定它不是人类访问者,并开始限制或阻止来自该客户端的所有请求。在为特定站点构建爬虫时,您需要仔细检查使用标准浏览器对用户隐藏的任何链接。 查看全部

抓取网页数据违法吗(网站所有者会为网站设置各种反抓取技术来阻止抓取工具)

网页抓取是一种经常用于自动化人类浏览行为的技术,以便有效地从网页中检索大量数据。各种网络抓取工具越来越受欢迎,并造福于各个领域的人们。由于过度的网络抓取会使网络服务器过载并导致服务器故障,网站所有者为网站设置了各种反爬虫技术来阻止爬虫,使得网络抓取更加困难。本文将重点介绍如何在不被阻止的情况下持续抓取网页。

1、放慢抓取速度

大多数网络抓取活动旨在尽快获取数据。当人们访问 网站 时,与网页抓取相比,浏览速度要慢得多。因此,网站 通过跟踪您的访问速度很容易将您作为爬虫捕获。因此,您可以在请求之间设置一些随机时间延迟,并减少一次对 1-2 个页面的并发页面访问。

2、,使用代理服务器

当站点检测到来自单个 IP 地址的多个请求时,它可以轻松阻止该 IP 地址。为了避免通过同一个 IP 地址发送所有请求,您可以使用代理服务器,您可以随机使用它们,将您的请求路由到不同的 IP 地址。

3、应用不同的抓取模式

人们通常在随机点击或查看时间浏览 网站,而网页抓取始终遵循与编程机器人遵循特定逻辑相同的抓取模式,反抓取机制可以通过识别在 网站 上执行的重复抓取行为来工作轻松检测爬虫。因此,您需要不时更改抓取模式并结合随机点击、鼠标移动或等待时间,以使网页抓取更加用户友好。

4、蜜罐陷阱

蜜罐是普通访问者看不到的链接,但存在于 HTML 代码中,并且可以被网络爬虫找到。它们就像陷阱,通过将刮板引导到空白页面来检测刮板。一旦特定访问者查看了蜜罐页面,网站 可以相对确定它不是人类访问者,并开始限制或阻止来自该客户端的所有请求。在为特定站点构建爬虫时,您需要仔细检查使用标准浏览器对用户隐藏的任何链接。

抓取网页数据违法吗(urllib2和urllib的第二种方案有什么区别?怎么做?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-02-02 08:02

urllib2 和 urllib 是 python 自己的模块,可以用来发送处理请求。虽然比较灵活,但是API不好用,一般需要封装两次。过去我也封装过,最后发现我封装的模块是无限流行的。它接近一个非常成熟的requests库,所以我们直接使用requests。当然,请求只是发送和接收请求。页面分析需要配合lxml或者beautifulsoup等第三方库。高级爬虫不仅发送和处理请求,还需要处理异常、请求速度控制等问题。这需要我们编写额外的代码来控制。当然,我们也可以自己写。这只是时间问题,但完全没有必要。

二、scrapy 框架

scrapy 是爬虫采集的领导者。目前,无论我做的项目多么复杂或复杂,我都使用scrapy。对于请求调度,已经封装了异常处理,第三方scrapy-redis也可以支持分布式,我们专注于更重要的页面分析和规则编写,代码可以参考我github上的例子。

三、python 硒

我称这种方法为终极杀手。一般在绝对没有办法的情况下使用。以前我使用搜索引擎爬取文章时,搜索引擎使用了比较难的反爬机制。而不断的变化,让人找不到规律。最典型的特点就是cookie会随机隐藏在某个页面的js和图片中。解决方法是模拟浏览器的行为加载js等所有静态资源文件。如果你自己写一个浏览器 解析太垃圾了。如果chrome浏览器可以打开界面,通过chrome加载方式获取页面内容,这就是selenium。Selenium 加上随机等待时间可以模拟非常类似于人类的操作行为。缺点是速度慢,但一般履带式对爬行速度要求不高,重要的是稳定性。这种方式比较适合大型网站爬取反爬机制。

综上,对于大部分爬虫的需求,直接用scrapy来解决。如果不能解决,可以使用第一种或第三种解决方案。就是这么简单。

python爬虫可以做什么

(1) 不同领域和背景的用户往往检索目的和需求不同,一般搜索引擎返回的结果中收录大量用户不关心的网页。

(2)一般搜索引擎的目标是最大化网络覆盖,有限的搜索引擎服务器资源和无限的网络数据资源之间的矛盾将进一步加深。

(3)万维网数据形式的丰富和网络技术的不断发展,催生了图片、数据库、音频、视频、多媒体等大量不同的数据。通用搜索对于这些信息内容密集、结构一定的数据,引擎往往无能为力。

(4)一般搜索引擎大多提供基于关键词的检索,难以支持基于语义信息的查询。

为了解决上述问题,出现了定向爬取相关网页资源的专注爬虫。聚焦爬虫是一种自动下载网页的程序。它根据给定的爬取目标有选择地访问万维网上的网页和相关链接,以获取所需的信息。与通用网络爬虫不同,聚焦爬虫不追求大覆盖,而是旨在爬取与特定主题内容相关的网页,并为面向主题的用户查询准备数据资源。

反爬虫

1. 基本的反爬方式主要是检测请求头中的字段,如:User-Agent、referer等,这种情况下只需要带上请求中对应的字段即可。构造的http请求的字段最好与浏览器中发送的字段完全相同,但不是必须的。

2. 基于用户行为的反爬方式主要统计后台访问的IP(或User-Agent)。当它超过某个阈值时,它将被阻止。针对这种情况,可以使用代理服务器解决,每隔几次请求,切换使用的代理的IP地址(或者使用User-Agent列表解决,每次从列表中随机选择一个) )。这种反爬虫方法可能会无意中伤害用户。

3.如果你要抓的数据是通过ajax请求获取的,如果通过网络分析可以找到ajax请求,也可以分析请求需要的具体参数,那么就可以模拟对应的http请求了直接,并在响应中获取对应的数据。在这种情况下,它与普通请求没有什么不同。

4. 基于JavaScript的反爬方式主要是在响应数据页之前返回一个带有JavaScript代码的页面,用于验证访问者是否有JavaScript执行环境,从而判断浏览器是否使用。.

通常,这段JS代码执行完后,会发送一个带参数key的请求,后台通过判断key的值来判断是响应真实页面还是响应假页面或错误页面。由于key参数是动态生成的,而且每次都不一样,很难分析其生成方式,无法构造出对应的http请求。 查看全部

抓取网页数据违法吗(urllib2和urllib的第二种方案有什么区别?怎么做?)

urllib2 和 urllib 是 python 自己的模块,可以用来发送处理请求。虽然比较灵活,但是API不好用,一般需要封装两次。过去我也封装过,最后发现我封装的模块是无限流行的。它接近一个非常成熟的requests库,所以我们直接使用requests。当然,请求只是发送和接收请求。页面分析需要配合lxml或者beautifulsoup等第三方库。高级爬虫不仅发送和处理请求,还需要处理异常、请求速度控制等问题。这需要我们编写额外的代码来控制。当然,我们也可以自己写。这只是时间问题,但完全没有必要。

二、scrapy 框架

scrapy 是爬虫采集的领导者。目前,无论我做的项目多么复杂或复杂,我都使用scrapy。对于请求调度,已经封装了异常处理,第三方scrapy-redis也可以支持分布式,我们专注于更重要的页面分析和规则编写,代码可以参考我github上的例子。

三、python 硒

我称这种方法为终极杀手。一般在绝对没有办法的情况下使用。以前我使用搜索引擎爬取文章时,搜索引擎使用了比较难的反爬机制。而不断的变化,让人找不到规律。最典型的特点就是cookie会随机隐藏在某个页面的js和图片中。解决方法是模拟浏览器的行为加载js等所有静态资源文件。如果你自己写一个浏览器 解析太垃圾了。如果chrome浏览器可以打开界面,通过chrome加载方式获取页面内容,这就是selenium。Selenium 加上随机等待时间可以模拟非常类似于人类的操作行为。缺点是速度慢,但一般履带式对爬行速度要求不高,重要的是稳定性。这种方式比较适合大型网站爬取反爬机制。

综上,对于大部分爬虫的需求,直接用scrapy来解决。如果不能解决,可以使用第一种或第三种解决方案。就是这么简单。

python爬虫可以做什么

(1) 不同领域和背景的用户往往检索目的和需求不同,一般搜索引擎返回的结果中收录大量用户不关心的网页。

(2)一般搜索引擎的目标是最大化网络覆盖,有限的搜索引擎服务器资源和无限的网络数据资源之间的矛盾将进一步加深。

(3)万维网数据形式的丰富和网络技术的不断发展,催生了图片、数据库、音频、视频、多媒体等大量不同的数据。通用搜索对于这些信息内容密集、结构一定的数据,引擎往往无能为力。

(4)一般搜索引擎大多提供基于关键词的检索,难以支持基于语义信息的查询。

为了解决上述问题,出现了定向爬取相关网页资源的专注爬虫。聚焦爬虫是一种自动下载网页的程序。它根据给定的爬取目标有选择地访问万维网上的网页和相关链接,以获取所需的信息。与通用网络爬虫不同,聚焦爬虫不追求大覆盖,而是旨在爬取与特定主题内容相关的网页,并为面向主题的用户查询准备数据资源。

反爬虫

1. 基本的反爬方式主要是检测请求头中的字段,如:User-Agent、referer等,这种情况下只需要带上请求中对应的字段即可。构造的http请求的字段最好与浏览器中发送的字段完全相同,但不是必须的。

2. 基于用户行为的反爬方式主要统计后台访问的IP(或User-Agent)。当它超过某个阈值时,它将被阻止。针对这种情况,可以使用代理服务器解决,每隔几次请求,切换使用的代理的IP地址(或者使用User-Agent列表解决,每次从列表中随机选择一个) )。这种反爬虫方法可能会无意中伤害用户。

3.如果你要抓的数据是通过ajax请求获取的,如果通过网络分析可以找到ajax请求,也可以分析请求需要的具体参数,那么就可以模拟对应的http请求了直接,并在响应中获取对应的数据。在这种情况下,它与普通请求没有什么不同。

4. 基于JavaScript的反爬方式主要是在响应数据页之前返回一个带有JavaScript代码的页面,用于验证访问者是否有JavaScript执行环境,从而判断浏览器是否使用。.

通常,这段JS代码执行完后,会发送一个带参数key的请求,后台通过判断key的值来判断是响应真实页面还是响应假页面或错误页面。由于key参数是动态生成的,而且每次都不一样,很难分析其生成方式,无法构造出对应的http请求。

抓取网页数据违法吗(北京网站开发不同类型的网站对于抓取份额的限制)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-02-01 15:06

不同类型的网站对爬取共享有什么限制吗?我们都知道百度百度权重是根据这个网站百度蜘蛛爬行后反馈的结果,我们做了很多网站优化的人都在研究蜘蛛爬行的规律。当然,网上也有很多相关的介绍。在这里,我将介绍不同类型的网站对爬取分享的限制。

中小企业网站建设是企业展示自身形象、发布产品信息、联系线上客户,进而通过电子商务开拓新市场、获得巨大收益的新平台、新天地只需很少的投资即可获得收益和利润。专业的网站专为生产网站。可以使用超文档标记语言、可扩展超文本标记语言等标记语言将文本、图片和表格等简单信息放置在网站页面上。以及矢量图形、动画、视频等更复杂的信息、音频等多媒体文件需要插件程序运行,也需要在网站中移植标记语言。

小网站页数少,即使网站百度权重低,服务器慢,每天爬的搜索引擎蜘蛛也少,一般至少几百页面可以被抓取。整个网站一次爬取,所以网站千页完全不用担心爬取分享。北京网站开发是基于B/S的网页开发,一般是交互的。也可以理解为开发就是生产,就是很多小生产带来的发展。网站 是由几个页面组成的相关集合。网站 几万页一般没什么大不了的。如果每天数百次访问会减慢服务器速度,那么 SEO 就不是主要问题。大中型网站 可能需要考虑抓取份额在几十万页以上的大中型网站,可能需要考虑抓取份额是否足够。抓取份额不够。比如网站有1000万个页面,而搜索引擎每天只能抓取几万个页面,所以一次网站可能需要几个月甚至一年的时间。一些重要页面无法爬取,所以没有排名,或者重要页面无法及时更新。所以爬一次网站可能需要几个月甚至一年的时间。一些重要页面无法爬取,所以没有排名,或者重要页面无法及时更新。所以爬一次网站可能需要几个月甚至一年的时间。一些重要页面无法爬取,所以没有排名,或者重要页面无法及时更新。

为了让 网站 页面被及时和充分的爬取,服务器必须足够快,页面必须足够小。如果网站有大量的优质数据,爬取份额会受到爬取率的限制,提高页面速度会直接提高爬取率限制,从而提高爬取份额。

可以看出爬取时间的提高(减小页面大小,提高服务器速度,优化数据库,明显导致爬取频率增加,从而爬取更多页面收录,遍历一次网站是比较快的 。

不同类型的网站抓取分享有什么限制吗?你看过这些文章你都学了吗? 查看全部

抓取网页数据违法吗(北京网站开发不同类型的网站对于抓取份额的限制)

不同类型的网站对爬取共享有什么限制吗?我们都知道百度百度权重是根据这个网站百度蜘蛛爬行后反馈的结果,我们做了很多网站优化的人都在研究蜘蛛爬行的规律。当然,网上也有很多相关的介绍。在这里,我将介绍不同类型的网站对爬取分享的限制。

中小企业网站建设是企业展示自身形象、发布产品信息、联系线上客户,进而通过电子商务开拓新市场、获得巨大收益的新平台、新天地只需很少的投资即可获得收益和利润。专业的网站专为生产网站。可以使用超文档标记语言、可扩展超文本标记语言等标记语言将文本、图片和表格等简单信息放置在网站页面上。以及矢量图形、动画、视频等更复杂的信息、音频等多媒体文件需要插件程序运行,也需要在网站中移植标记语言。

小网站页数少,即使网站百度权重低,服务器慢,每天爬的搜索引擎蜘蛛也少,一般至少几百页面可以被抓取。整个网站一次爬取,所以网站千页完全不用担心爬取分享。北京网站开发是基于B/S的网页开发,一般是交互的。也可以理解为开发就是生产,就是很多小生产带来的发展。网站 是由几个页面组成的相关集合。网站 几万页一般没什么大不了的。如果每天数百次访问会减慢服务器速度,那么 SEO 就不是主要问题。大中型网站 可能需要考虑抓取份额在几十万页以上的大中型网站,可能需要考虑抓取份额是否足够。抓取份额不够。比如网站有1000万个页面,而搜索引擎每天只能抓取几万个页面,所以一次网站可能需要几个月甚至一年的时间。一些重要页面无法爬取,所以没有排名,或者重要页面无法及时更新。所以爬一次网站可能需要几个月甚至一年的时间。一些重要页面无法爬取,所以没有排名,或者重要页面无法及时更新。所以爬一次网站可能需要几个月甚至一年的时间。一些重要页面无法爬取,所以没有排名,或者重要页面无法及时更新。

为了让 网站 页面被及时和充分的爬取,服务器必须足够快,页面必须足够小。如果网站有大量的优质数据,爬取份额会受到爬取率的限制,提高页面速度会直接提高爬取率限制,从而提高爬取份额。

可以看出爬取时间的提高(减小页面大小,提高服务器速度,优化数据库,明显导致爬取频率增加,从而爬取更多页面收录,遍历一次网站是比较快的 。

不同类型的网站抓取分享有什么限制吗?你看过这些文章你都学了吗?

抓取网页数据违法吗(关于python爬虫的一些事儿,你了解多少?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-01-29 22:06

这个问题在我没有接触到这条线的时候困扰了我很久,也让我不明白什么是爬虫。它是实体工具吗?,直到我学会了python来深入分析和理解它。

什么是爬行动物?有简单爬虫和复杂爬虫之分。其实简单的爬虫就是一个脚本,一个程序或者脚本,按照一定的规则自动从万维网上抓取信息。

脚本很粗糙,但往往是非常实用的小程序(一般不超过几千行,有时只有几百行代码)。举个简单的例子,您现在正在阅读来自学生出租屋 网站 的学生公寓出租信息。你一个一个地复制肯定是不现实的。所以使用爬行动物。信息类别 网站 中的数千条信息可以一次全部提取。你也可以把百度、谷歌等搜索引擎想象成一种爬虫,但这种技术非常复杂,不是简单的脚本。

搜索引擎是如何工作的?事实上,通过网络爬虫技术,将互联网上数百亿的网页信息保存在本地,形成镜像文件,为整个搜索引擎提供数据支持。

这样的技术首先会涉及到一个非常重要且大家都关心的问题——是否违法?

经过仔细研究,得出以下结论:

1.遵守Robots协议,但Robots的存在并不代表你可以自由爬行。

2.限制你的爬虫行为,禁止接近DDOS的请求频率。服务器一旦瘫痪,就相当于网络攻击;

3.强行突破明显反爬或者正常情况下无法到达的页面,否则是Hacker行为;

4.回顾你正在攀登的东西,永远不要触碰法律的红线。

至此,您应该明白爬虫本身并不违法,但取决于您使用的方式和目的,也取决于它的商业用途。

如果你对python爬虫1感兴趣或者可以私聊我 查看全部

抓取网页数据违法吗(关于python爬虫的一些事儿,你了解多少?(一))

这个问题在我没有接触到这条线的时候困扰了我很久,也让我不明白什么是爬虫。它是实体工具吗?,直到我学会了python来深入分析和理解它。

什么是爬行动物?有简单爬虫和复杂爬虫之分。其实简单的爬虫就是一个脚本,一个程序或者脚本,按照一定的规则自动从万维网上抓取信息。

脚本很粗糙,但往往是非常实用的小程序(一般不超过几千行,有时只有几百行代码)。举个简单的例子,您现在正在阅读来自学生出租屋 网站 的学生公寓出租信息。你一个一个地复制肯定是不现实的。所以使用爬行动物。信息类别 网站 中的数千条信息可以一次全部提取。你也可以把百度、谷歌等搜索引擎想象成一种爬虫,但这种技术非常复杂,不是简单的脚本。

搜索引擎是如何工作的?事实上,通过网络爬虫技术,将互联网上数百亿的网页信息保存在本地,形成镜像文件,为整个搜索引擎提供数据支持。

这样的技术首先会涉及到一个非常重要且大家都关心的问题——是否违法?

经过仔细研究,得出以下结论:

1.遵守Robots协议,但Robots的存在并不代表你可以自由爬行。

2.限制你的爬虫行为,禁止接近DDOS的请求频率。服务器一旦瘫痪,就相当于网络攻击;

3.强行突破明显反爬或者正常情况下无法到达的页面,否则是Hacker行为;

4.回顾你正在攀登的东西,永远不要触碰法律的红线。

至此,您应该明白爬虫本身并不违法,但取决于您使用的方式和目的,也取决于它的商业用途。

如果你对python爬虫1感兴趣或者可以私聊我

抓取网页数据违法吗(网络爬虫()模拟浏览器发送网络请求,接收请求响应)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2022-01-29 10:01

爬虫概述

网络爬虫(也称为网络蜘蛛或网络机器人)是模拟浏览器发送网络请求和接收请求响应的程序。它是一个按照一定的规则自动抓取互联网信息的程序。

原则上,只要浏览器(客户端)可以做任何事情,爬虫就可以做到。

1. 爬虫是非法的吗?2.爬虫的潜在风险3.如何规避风险?始终维护自己的爬虫程序,避免干扰访问的网站的正常运行。传播爬取的数据时,检查你抓取的内容。如发现涉及用户隐私或商业秘密的违法内容应及时停止爬取和传播,及时删除数据。4.爬虫分类一般爬虫:重点爬虫:增量爬虫:5. 爬行者的矛与盾5.1 反向爬升机制

传送门网站,可以通过指定相应的策略或技术手段,防止爬虫程序爬取数据网站

5.2 反反爬策略

爬虫还可以通过制定相关政策和相关技术手段破解门户网站中的反爬机制,获取门户网站的数据。

6. 机器人协议

这是君子的约定。即网站可以指定网站中的数据可以被爬虫爬取,那些数据不能被爬取。可能会或可能不会遵守

可以通过将 /robots.txt 附加到目标 URL 来访问目标 URL 的 robots 协议

7.http协议概念:通用请求头信息:通用响应头信息8.https协议8.1加密方式对称密钥加密非对称密钥加密证书密钥加密 查看全部

抓取网页数据违法吗(网络爬虫()模拟浏览器发送网络请求,接收请求响应)

爬虫概述

网络爬虫(也称为网络蜘蛛或网络机器人)是模拟浏览器发送网络请求和接收请求响应的程序。它是一个按照一定的规则自动抓取互联网信息的程序。

原则上,只要浏览器(客户端)可以做任何事情,爬虫就可以做到。

1. 爬虫是非法的吗?2.爬虫的潜在风险3.如何规避风险?始终维护自己的爬虫程序,避免干扰访问的网站的正常运行。传播爬取的数据时,检查你抓取的内容。如发现涉及用户隐私或商业秘密的违法内容应及时停止爬取和传播,及时删除数据。4.爬虫分类一般爬虫:重点爬虫:增量爬虫:5. 爬行者的矛与盾5.1 反向爬升机制

传送门网站,可以通过指定相应的策略或技术手段,防止爬虫程序爬取数据网站

5.2 反反爬策略

爬虫还可以通过制定相关政策和相关技术手段破解门户网站中的反爬机制,获取门户网站的数据。

6. 机器人协议

这是君子的约定。即网站可以指定网站中的数据可以被爬虫爬取,那些数据不能被爬取。可能会或可能不会遵守

可以通过将 /robots.txt 附加到目标 URL 来访问目标 URL 的 robots 协议

7.http协议概念:通用请求头信息:通用响应头信息8.https协议8.1加密方式对称密钥加密非对称密钥加密证书密钥加密

抓取网页数据违法吗( 新站好几个月不收录内页什么原因造成的呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 70 次浏览 • 2022-01-29 03:02

新站好几个月不收录内页什么原因造成的呢?)

如果下载的源代码需要作者授权,请更换源代码。本站资源免费共享不会增加授权

现在越来越多的公司在做网站优化。对于新站优化,一定要注意细节。要知道新建站点页面收录会比较久,但是我们发现有些新站点几个月都没有收录内页。这是什么原因?让我们一起来看看这些。

1、内页质量很低

内容质量很差,根本不值得一读。文章版面凌乱,字体大小和颜色不统一,文章的内容还穿插了一些不必要的锚文本链接和一些广告链接。(1)首先要修改上面提到的所有项目,给文章增加可读性和附加值。(2)分析长尾词的要求,布局内容,看需求解决用户问题(3)丰富网页内容

2、太多样板文本,太多页面相似度

Boilerplate text是指大部分页面都会有的内容,比如垂直导航、推荐文章、联系我们、上一篇、下一篇等等。这些词越多,页面之间的相似度就越大。并且有些页面除了这些内容之外只有一张产品图片,并且这些页面的相似度是100%。为什么搜索引擎想要收录这么多相同的内容?因此,请务必减少样板文本并提高每个页面的质量。

3、内部页面权重不足

内页权重不够或 网站 权重不够。每个收录的网页在权重值达到一定值后,需要被搜索引擎收录。如果 网站 权重不够,则无法传递给权重好的网页。解决的办法是多做一些高权重的外链或者为栏目页和内页做一些友好的外链和外链。

4、网站信用低

新站的可信度主要来自于更新频率和内容质量,老站的可信度来自于内容的质量,内容也一样。内容质量很好,用户很乐意点击。

如何吸引蜘蛛抓取页面

网站 和页面的权重大家都知道。网站 和页面的权重越高,蜘蛛爬得越深,被蜘蛛收录 的页面就越多。. 但是一个权重为1的新网站还是比较容易的,但是如果要在线增加权重,那就越来越难了。

页面的更新程度和更新频率。每次爬虫爬取网站,都会将这些页面的数据保存到数据库中。作为对比,如果该页面与上一页相同,则说明该页面尚未更新,这样的页面蜘蛛会降低爬取的频率,甚至不爬取。相反,如果页面有更新或者有新的链接,蜘蛛就会根据新的链接爬到新的页面,所以很容易增加收录的数量。

外部链接和友情链接 很多所谓的SEO人员认为做网站优化就是不断的发送外部链接。当然,发送大量的外部链接会很好。我们可以肯定,对网站和收录的外链排名是有好处的,但这并不代表SEO就是发外链。其实真正的网站优化了SEO,即使不发外链,依然会有不错的排名。当然,我们现在说的是外链的作用,其他的就不深入讨论了。如果你想让蜘蛛知道你的链接,你需要去蜘蛛经常爬的地方,放一些网站链接,以吸引蜘蛛爬你的网站不是吗?这些导入链接称为外部链接。其实友情链接也是外链的一种,但是因为友情链接的效果其实比外链的效果要好,所以这里把小资区分开来了。正是因为外链有吸引蜘蛛的作用,所以我们在发布新的网站的时候,一般都会去一些收录效果比较好的平台发布一些外链,这样我们可以更快地让蜘蛛收录我们的网站。

很多站长不注意页面深度的问题。其实这个问题对网站的优化影响很大。一般我们可以去二级和三级目录。如果单个页面深入,蜘蛛可能会爬不上去,用户体验不是很好,页面权重会越来越低,所以站长一定要注意不要让页面离首页太远。 查看全部

抓取网页数据违法吗(

新站好几个月不收录内页什么原因造成的呢?)

如果下载的源代码需要作者授权,请更换源代码。本站资源免费共享不会增加授权

现在越来越多的公司在做网站优化。对于新站优化,一定要注意细节。要知道新建站点页面收录会比较久,但是我们发现有些新站点几个月都没有收录内页。这是什么原因?让我们一起来看看这些。

1、内页质量很低

内容质量很差,根本不值得一读。文章版面凌乱,字体大小和颜色不统一,文章的内容还穿插了一些不必要的锚文本链接和一些广告链接。(1)首先要修改上面提到的所有项目,给文章增加可读性和附加值。(2)分析长尾词的要求,布局内容,看需求解决用户问题(3)丰富网页内容

2、太多样板文本,太多页面相似度

Boilerplate text是指大部分页面都会有的内容,比如垂直导航、推荐文章、联系我们、上一篇、下一篇等等。这些词越多,页面之间的相似度就越大。并且有些页面除了这些内容之外只有一张产品图片,并且这些页面的相似度是100%。为什么搜索引擎想要收录这么多相同的内容?因此,请务必减少样板文本并提高每个页面的质量。

3、内部页面权重不足

内页权重不够或 网站 权重不够。每个收录的网页在权重值达到一定值后,需要被搜索引擎收录。如果 网站 权重不够,则无法传递给权重好的网页。解决的办法是多做一些高权重的外链或者为栏目页和内页做一些友好的外链和外链。

4、网站信用低

新站的可信度主要来自于更新频率和内容质量,老站的可信度来自于内容的质量,内容也一样。内容质量很好,用户很乐意点击。

如何吸引蜘蛛抓取页面

网站 和页面的权重大家都知道。网站 和页面的权重越高,蜘蛛爬得越深,被蜘蛛收录 的页面就越多。. 但是一个权重为1的新网站还是比较容易的,但是如果要在线增加权重,那就越来越难了。

页面的更新程度和更新频率。每次爬虫爬取网站,都会将这些页面的数据保存到数据库中。作为对比,如果该页面与上一页相同,则说明该页面尚未更新,这样的页面蜘蛛会降低爬取的频率,甚至不爬取。相反,如果页面有更新或者有新的链接,蜘蛛就会根据新的链接爬到新的页面,所以很容易增加收录的数量。

外部链接和友情链接 很多所谓的SEO人员认为做网站优化就是不断的发送外部链接。当然,发送大量的外部链接会很好。我们可以肯定,对网站和收录的外链排名是有好处的,但这并不代表SEO就是发外链。其实真正的网站优化了SEO,即使不发外链,依然会有不错的排名。当然,我们现在说的是外链的作用,其他的就不深入讨论了。如果你想让蜘蛛知道你的链接,你需要去蜘蛛经常爬的地方,放一些网站链接,以吸引蜘蛛爬你的网站不是吗?这些导入链接称为外部链接。其实友情链接也是外链的一种,但是因为友情链接的效果其实比外链的效果要好,所以这里把小资区分开来了。正是因为外链有吸引蜘蛛的作用,所以我们在发布新的网站的时候,一般都会去一些收录效果比较好的平台发布一些外链,这样我们可以更快地让蜘蛛收录我们的网站。

很多站长不注意页面深度的问题。其实这个问题对网站的优化影响很大。一般我们可以去二级和三级目录。如果单个页面深入,蜘蛛可能会爬不上去,用户体验不是很好,页面权重会越来越低,所以站长一定要注意不要让页面离首页太远。

抓取网页数据违法吗((将以下网站地址视为占位符):我的脚本 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-01-29 03:01

)

我正在尝试创建一个脚本,我可以使用它来解析 网站 中的多个字段而不会被阻止。我希望从中获取数据的站点需要凭据才能访问其内容。如果不是为了登录,我可以使用代理轮换来绕过速率限制。

当我从基于登录的网站上抓取内容时,我试图找出任何方法来避免在从那里抓取数据时被该网站禁止。具体来说,我的脚本目前可以完美地从站点获取内容,但是如果我继续抓取,我的 IP 地址会在此过程中被禁止。

到目前为止我所写的内容(将以下 网站 地址视为占位符):

import requests

from bs4 import BeautifulSoup

url = "https://stackoverflow.com/user ... ot%3B

with requests.Session() as s:

s.headers['User-Agent'] = 'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.104 Safari/537.36'

req = s.get(url)

payload = {

"fkey": BeautifulSoup(req.text,"lxml").select_one("[name='fkey']")["value"],

"email": "some email",

"password": "some password",

}

res = s.post(url,data=payload)

soup = BeautifulSoup(res.text,"lxml")

for post_title in soup.select(".summary > h3 > a.question-hyperlink"):

print(post_title.text)

从基于登录的网站抓取数据时如何避免被禁止? 查看全部

抓取网页数据违法吗((将以下网站地址视为占位符):我的脚本

)

我正在尝试创建一个脚本,我可以使用它来解析 网站 中的多个字段而不会被阻止。我希望从中获取数据的站点需要凭据才能访问其内容。如果不是为了登录,我可以使用代理轮换来绕过速率限制。

当我从基于登录的网站上抓取内容时,我试图找出任何方法来避免在从那里抓取数据时被该网站禁止。具体来说,我的脚本目前可以完美地从站点获取内容,但是如果我继续抓取,我的 IP 地址会在此过程中被禁止。

到目前为止我所写的内容(将以下 网站 地址视为占位符):

import requests

from bs4 import BeautifulSoup

url = "https://stackoverflow.com/user ... ot%3B

with requests.Session() as s:

s.headers['User-Agent'] = 'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/88.0.4324.104 Safari/537.36'

req = s.get(url)

payload = {

"fkey": BeautifulSoup(req.text,"lxml").select_one("[name='fkey']")["value"],

"email": "some email",

"password": "some password",

}

res = s.post(url,data=payload)

soup = BeautifulSoup(res.text,"lxml")

for post_title in soup.select(".summary > h3 > a.question-hyperlink"):

print(post_title.text)

从基于登录的网站抓取数据时如何避免被禁止?

抓取网页数据违法吗(为什么要用python写爬虫是什么意思呢?怎么写)

网站优化 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2022-01-28 15:16

Python是一种计算机编程语言。它是众多计算机编程语言中最容易学习的一种。也被大家广泛使用和喜爱。这个python爬虫是什么意思?为什么用python写爬虫,其他编程语言不行?今天,让我们通过IP代理向导了解一下python爬虫的一些基础知识。

一、python爬虫是什么意思

爬虫:是按照一定的规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。

即:打开一个网页,有一个工具,可以获取网页上的内容并保存到你想要的地方,这个工具就是爬虫。

Python爬虫架构组成:

1.网页解析器,解析一个网页字符串,可以根据我们的需求提取我们有用的信息,或者按照DOM树的解析方式进行解析。

2.URL管理器:包括要爬取的URL地址和已经爬取过的URL地址,防止重复URL爬取和URL循环爬取。URL Manager的实现方式主要有3种,通过内存、数据库、Cache数据库来实现。

3.网页下载器:通过传入URL地址下载网页,并将网页转换为字符串。网页下载器有urllib2(Python官方基础模块),包括需要登录、代理、cookies、requests(第1节)三方包)

4.Scheduler:相当于一台计算机的CPU,主要负责URL管理器、下载器、解析器之间的调度协调。

5.应用程序:由从网页中提取的有用数据组成的应用程序。

二、爬虫如何抓取数据

1. 爬网

爬取网页有时需要模拟浏览器的行为,很多网站都被屏蔽了用于生硬的爬虫爬取。这就是我们需要模拟用户代理的行为来构造适当的请求的地方,例如模拟用户登录,模拟会话/cookie存储和设置。

2.爬取后处理

抓取的网页通常需要进行处理,比如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。

以上介绍了python爬虫的一些基础知识。相信大家对“python爬虫是什么意思”和“爬虫是如何爬取数据的”都有一定的了解。在大数据时代,很多人在学习python的时候都是从爬虫开始的,越来越多的人在学习网络爬虫。通常使用爬虫爬取数据会遇到IP限制。IP代理向导是一款非常实用的IP更换工具,可以突破IP限制,帮助爬虫突破网站限制次数。 查看全部

抓取网页数据违法吗(为什么要用python写爬虫是什么意思呢?怎么写)

Python是一种计算机编程语言。它是众多计算机编程语言中最容易学习的一种。也被大家广泛使用和喜爱。这个python爬虫是什么意思?为什么用python写爬虫,其他编程语言不行?今天,让我们通过IP代理向导了解一下python爬虫的一些基础知识。

一、python爬虫是什么意思

爬虫:是按照一定的规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。

即:打开一个网页,有一个工具,可以获取网页上的内容并保存到你想要的地方,这个工具就是爬虫。

Python爬虫架构组成:

1.网页解析器,解析一个网页字符串,可以根据我们的需求提取我们有用的信息,或者按照DOM树的解析方式进行解析。

2.URL管理器:包括要爬取的URL地址和已经爬取过的URL地址,防止重复URL爬取和URL循环爬取。URL Manager的实现方式主要有3种,通过内存、数据库、Cache数据库来实现。

3.网页下载器:通过传入URL地址下载网页,并将网页转换为字符串。网页下载器有urllib2(Python官方基础模块),包括需要登录、代理、cookies、requests(第1节)三方包)

4.Scheduler:相当于一台计算机的CPU,主要负责URL管理器、下载器、解析器之间的调度协调。

5.应用程序:由从网页中提取的有用数据组成的应用程序。

二、爬虫如何抓取数据

1. 爬网

爬取网页有时需要模拟浏览器的行为,很多网站都被屏蔽了用于生硬的爬虫爬取。这就是我们需要模拟用户代理的行为来构造适当的请求的地方,例如模拟用户登录,模拟会话/cookie存储和设置。

2.爬取后处理

抓取的网页通常需要进行处理,比如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用极短的代码完成大部分文档处理。

其实很多语言和工具都可以做到以上功能,但是python可以做到最快最干净。

以上介绍了python爬虫的一些基础知识。相信大家对“python爬虫是什么意思”和“爬虫是如何爬取数据的”都有一定的了解。在大数据时代,很多人在学习python的时候都是从爬虫开始的,越来越多的人在学习网络爬虫。通常使用爬虫爬取数据会遇到IP限制。IP代理向导是一款非常实用的IP更换工具,可以突破IP限制,帮助爬虫突破网站限制次数。

抓取网页数据违法吗(马化腾:“万物皆媒”正重塑信息内容生态,带来新的治理需求 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-01-25 21:07

)

相关话题

谷歌的新鲜度算法增强了实时信息内容

4/11/201109:22:00

谷歌调整搜索引擎算法,强化实时信息内容,称为“新鲜度算法”。主要强调时间因素的影响,强化实时信息内容。它使用谷歌咖啡因网络索引系统,可以更快地抓取网站内容。

信息内容治理初见成效,网络生态整体提升

1/7/202012:01:28

马化腾:“万物皆媒介”重塑信息内容生态带来新治理需求

27/9/202015:01:48

(原标题:马化腾:《万物皆媒体》正在重塑信息内容生态,带来新的治理需求)

vue实现员工信息录入功能的方法

13/7/202009:08:43

vue通用信息输入界面,供大家参考,具体内容如下员工信息输入.btn1{color

如何提高信息录入效率

2018 年 9 月 1 日 11:49:00

每个 UI 设计师都希望自己的产品受到用户的喜爱,那么如何才能做到呢?今天,我们不妨从提高信息录入效率的角度来优化产品用户体验。因为UI设计本质上就是为用户创造一个界面来完成交互,说白了就是人与机器(手机、电脑)之间的交流,提高信息录入的效率就意味着加快交流的速度。

如何提高信息录入效率

2018 年 9 月 1 日 11:49:00

每个 UI 设计师都希望自己的产品受到用户的喜爱,那么如何才能做到呢?今天,我们不妨从提高信息录入效率的角度来优化产品用户体验。因为UI设计本质上就是为用户创造一个界面来完成交互,说白了就是人与机器(手机、电脑)之间的交流,提高信息录入的效率就意味着加快交流的速度。

使用webpasser 抓取一个笑话网站全站内容

2018 年 4 月 3 日 01:07:49

总结:使用webpasser框架抓取一个笑话网站整个网站内容。webpasser 是一个可配置的爬虫框架,内置页面解析引擎,可以快速配置爬虫任务。配置方法将页面解析和数据存储分开。如果目标网站被修改,也可以快速修复。配置说明如下:

国家网信办开展移动应用信息内容乱象专项整治

5/11/202018:04:32

中新网11月5日电(记者 程梦玲)国家网信办自11月5日起开展为期45天的手机应用信息内容乱象专项整治,聚焦乱象,重拳出击,重点整治非法移动应用应用程序。中国网信办负责

网站SEO 蜘蛛如何快速抓取内容

21/7/202012:07:21

今天小编要分享的是网站内容是如何被SEO蜘蛛快速爬取的。这个网站的内容应该是百度秒收的,这些事情还是要你做的。首先,网站域名的最佳选择是“短而老”的网站域名,比如

如何善用博客或网站上的标签?

28/1/2010 08:55:00

用于博客和 网站 的强大但未充分利用的工具之一是标记页面或博客文章。有效地使用标签并不容易。在这篇文章中,我将通过几个例子来说明如何使用标签来充分利用它们,以及需要注意的问题和一些高级策略。

优化网站,让搜索引擎更容易抓取和收录内容

2009 年 5 月 11 日 11:36:00

许多关于网站结构、爬取和收录,甚至排名的问题都可以归结为一个核心问题:搜索引擎能多容易地爬取你的网站?我们已经在最近的几次活动中讨论了这个主题,您将在下面找到我们关于该主题的演示摘要和要点摘要。

网站标签在优化中有什么用?

28/7/202018:07:22

tag标签是一种可以自行定义的关键词,比分类标签更具体准确,可以概括文章的主要内容。那么网站的优化中使用tag标签有什么用呢?

Tag技术在网站优化中的作用

25/8/2017 15:21:00

标签(中文称为“标签”)是一种组织和管理在线信息的新方式。它不同于传统的关键词搜索文件本身,而是一种模糊而智能的分类。标记(tag)是一种更灵活有趣的日志分类方式。您可以为每条日志添加一个或多个标签(tags),然后您就可以看到东行日志上所有与您使用相同标签的日志。日志,因此和其他

网站优化:TAG标签更有益。你用过网站吗?

15/7/2013 14:20:00

一些随处可见的大型网站已经熟练使用了TAG标签,今天想和大家讨论这个话题,因为很多中小型网站往往忽略了TAG标签的作用TAG标签我什至不知道TAG标签能给网站带来什么好处,所以今天给大家详细分享一下。

《互联网直播营销信息内容服务管理条例(征求意见稿)》发布

16/11/202012:06:58

为加强互联网直播营销信息内容服务管理,维护国家安全和公共利益,保护自然人、法人和非法人组织的合法权益,促进互联网直播健康有序发展营销行业,据《中华人民共和国网络

查看全部

抓取网页数据违法吗(马化腾:“万物皆媒”正重塑信息内容生态,带来新的治理需求

)

相关话题

谷歌的新鲜度算法增强了实时信息内容

4/11/201109:22:00

谷歌调整搜索引擎算法,强化实时信息内容,称为“新鲜度算法”。主要强调时间因素的影响,强化实时信息内容。它使用谷歌咖啡因网络索引系统,可以更快地抓取网站内容。

信息内容治理初见成效,网络生态整体提升

1/7/202012:01:28

马化腾:“万物皆媒介”重塑信息内容生态带来新治理需求

27/9/202015:01:48

(原标题:马化腾:《万物皆媒体》正在重塑信息内容生态,带来新的治理需求)

vue实现员工信息录入功能的方法

13/7/202009:08:43

vue通用信息输入界面,供大家参考,具体内容如下员工信息输入.btn1{color

如何提高信息录入效率

2018 年 9 月 1 日 11:49:00

每个 UI 设计师都希望自己的产品受到用户的喜爱,那么如何才能做到呢?今天,我们不妨从提高信息录入效率的角度来优化产品用户体验。因为UI设计本质上就是为用户创造一个界面来完成交互,说白了就是人与机器(手机、电脑)之间的交流,提高信息录入的效率就意味着加快交流的速度。

如何提高信息录入效率

2018 年 9 月 1 日 11:49:00

每个 UI 设计师都希望自己的产品受到用户的喜爱,那么如何才能做到呢?今天,我们不妨从提高信息录入效率的角度来优化产品用户体验。因为UI设计本质上就是为用户创造一个界面来完成交互,说白了就是人与机器(手机、电脑)之间的交流,提高信息录入的效率就意味着加快交流的速度。

使用webpasser 抓取一个笑话网站全站内容

2018 年 4 月 3 日 01:07:49

总结:使用webpasser框架抓取一个笑话网站整个网站内容。webpasser 是一个可配置的爬虫框架,内置页面解析引擎,可以快速配置爬虫任务。配置方法将页面解析和数据存储分开。如果目标网站被修改,也可以快速修复。配置说明如下:

国家网信办开展移动应用信息内容乱象专项整治

5/11/202018:04:32

中新网11月5日电(记者 程梦玲)国家网信办自11月5日起开展为期45天的手机应用信息内容乱象专项整治,聚焦乱象,重拳出击,重点整治非法移动应用应用程序。中国网信办负责

网站SEO 蜘蛛如何快速抓取内容

21/7/202012:07:21

今天小编要分享的是网站内容是如何被SEO蜘蛛快速爬取的。这个网站的内容应该是百度秒收的,这些事情还是要你做的。首先,网站域名的最佳选择是“短而老”的网站域名,比如

如何善用博客或网站上的标签?

28/1/2010 08:55:00

用于博客和 网站 的强大但未充分利用的工具之一是标记页面或博客文章。有效地使用标签并不容易。在这篇文章中,我将通过几个例子来说明如何使用标签来充分利用它们,以及需要注意的问题和一些高级策略。

优化网站,让搜索引擎更容易抓取和收录内容

2009 年 5 月 11 日 11:36:00

许多关于网站结构、爬取和收录,甚至排名的问题都可以归结为一个核心问题:搜索引擎能多容易地爬取你的网站?我们已经在最近的几次活动中讨论了这个主题,您将在下面找到我们关于该主题的演示摘要和要点摘要。

网站标签在优化中有什么用?

28/7/202018:07:22

tag标签是一种可以自行定义的关键词,比分类标签更具体准确,可以概括文章的主要内容。那么网站的优化中使用tag标签有什么用呢?

Tag技术在网站优化中的作用

25/8/2017 15:21:00

标签(中文称为“标签”)是一种组织和管理在线信息的新方式。它不同于传统的关键词搜索文件本身,而是一种模糊而智能的分类。标记(tag)是一种更灵活有趣的日志分类方式。您可以为每条日志添加一个或多个标签(tags),然后您就可以看到东行日志上所有与您使用相同标签的日志。日志,因此和其他

网站优化:TAG标签更有益。你用过网站吗?

15/7/2013 14:20:00

一些随处可见的大型网站已经熟练使用了TAG标签,今天想和大家讨论这个话题,因为很多中小型网站往往忽略了TAG标签的作用TAG标签我什至不知道TAG标签能给网站带来什么好处,所以今天给大家详细分享一下。

《互联网直播营销信息内容服务管理条例(征求意见稿)》发布

16/11/202012:06:58

为加强互联网直播营销信息内容服务管理,维护国家安全和公共利益,保护自然人、法人和非法人组织的合法权益,促进互联网直播健康有序发展营销行业,据《中华人民共和国网络

抓取网页数据违法吗(你期待已久的Python网络数据爬虫教程来了。为你演示 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2022-01-25 12:00

)

你期待已久的 Python 网络数据爬虫教程就在这里。本文向您展示了如何从网页中查找感兴趣的链接和描述,并在 Excel 中抓取和存储它们。

需要

我在公众号后台,经常能收到读者留言。

许多评论是读者的问题。只要我有时间,我会尝试回答它。

但是,有些消息乍一看并不清楚。

比如这个:

过了一分钟,他可能觉得不妥(可能是他记起来了,我用简体写了文章),于是又用简体发了一遍。

我恍然大悟。

这位读者以为我的公众号设置了关键词推送对应文章的功能。所以在阅读了我的其他数据科学教程之后,我想看看“爬虫”这个话题。

抱歉,我当时没有写 crawler文章。

而且我的公众号暂时没有设置这种关键词推送。

主要是因为我懒。

这类新闻收到不少,也能体会到读者的需求。不止一位读者对爬虫教程表示了兴趣。

如前所述,目前主流且合法的网络数据采集方式主要分为三类:

前两种方法我已经介绍过了,这次就讲爬虫。

概念

很多读者对爬虫的定义有些混淆。我们需要对其进行分析。

维基百科是这样说的:

网络爬虫,也称为网络蜘蛛,是一种用于自动浏览万维网的网络机器人。它的目的通常是编译一个网络索引。

这就是问题。你不打算成为搜索引擎,那你为什么对网络爬虫如此热衷?

事实上,许多人所说的网络爬虫与另一个功能“网络抓取”相混淆。

在维基百科上,后者是这样解释的:

Web 抓取、Web 采集或 Web 数据提取是用于从网站中提取数据的数据抓取。Web 抓取软件可以使用超文本传输协议或通过 Web 浏览器直接访问万维网。

看不,即使您使用浏览器手动复制数据,也称为网络抓取。你是不是立刻感觉强壮了很多?

但是,这个定义并不完整:

虽然网络抓取可以由软件用户手动完成,但该术语通常是指使用机器人或网络爬虫实现的自动化流程。

换句话说,使用爬虫(或机器人)自动为您完成网络抓取工作是您真正想要的。

你用数据做什么?

通常,它首先存储并放置在数据库或电子表格中以供检索或进一步分析。

所以,你真正想要的功能是:

找到链接,获取网页,抓取指定信息,存储。

这个过程可能会来回走动,甚至滚雪球。

你想自动化它。

知道了这一点,你就可以停止盯着爬虫了。实际上,爬虫是为搜索引擎索引数据库而开发的。为了获取一些数据并使用它,你已经在轰炸蚊子了。

要真正掌握爬虫,你需要有很多基础知识。例如 HTML、CSS、Javascript、数据结构……

这也是我一直犹豫要不要写爬虫教程的原因。

不过这两天看到王朔编辑的一段话,很有启发性:

我喜欢讲一个二十八的替代法则,即投入20%的努力,理解一件事的80%。

既然我们的目标很明确,那就是从网络上抓取数据。那么你需要掌握的最重要的能力就是如何在获得网页链接后快速有效地抓取你想要的信息。

掌握了之后,就不能说你学会了爬行。

但是有了这个基础,您可以比以往更轻松地获取数据。尤其是对于“文科生”的很多应用场景来说,是非常有用的。这是赋权。

此外,进一步了解爬虫的工作原理变得容易得多。

这也是“替代 28 规则”的应用。

Python 语言的重要特性之一是强大的软件工具包的可用性(许多由第三方提供)。您只需要编写一个简单的程序即可自动解析网页并抓取数据。

本文向您展示了该过程。

目标

要抓取网络数据,让我们从一个小目标开始。

目标不能太复杂。但是这样做,它应该可以帮助您了解 Web Scraping。

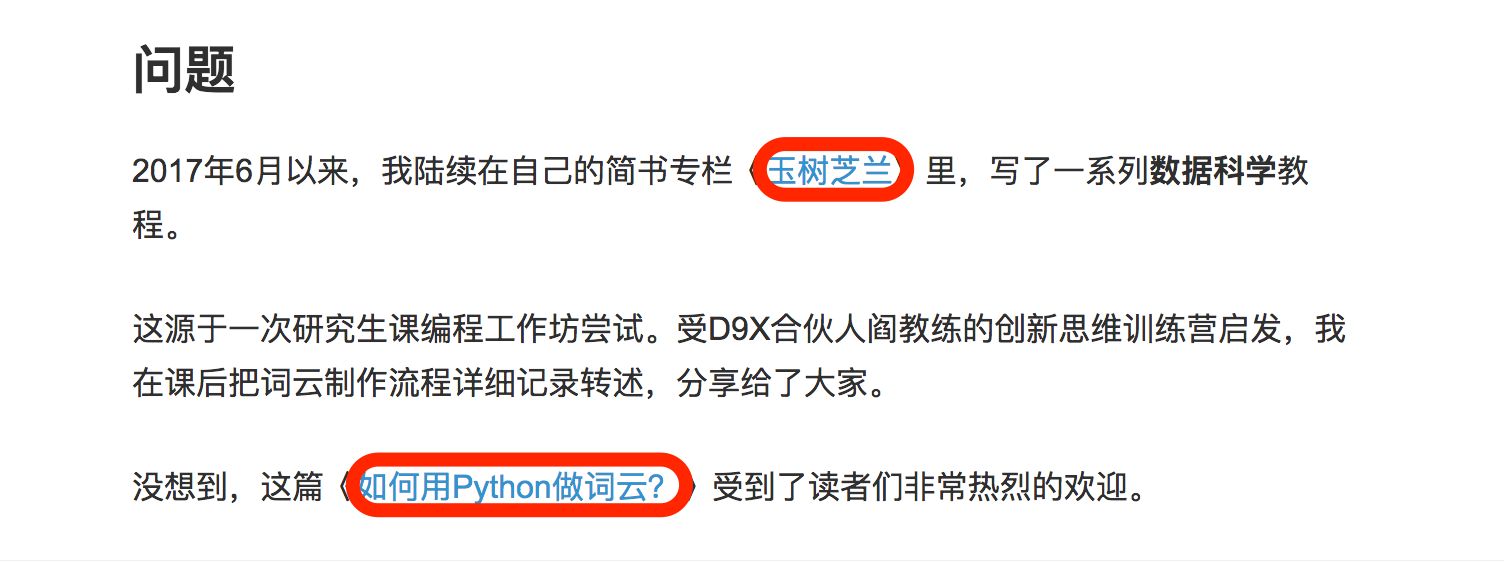

只需选择我最近发布的一本简短的书文章作为要抓取的对象。题目叫“如何使用《玉树之兰》开始数据科学?”。

在这个文章中,我重新组织并串起了我之前的数据科学系列文章。

文本收录许多以前教程的标题和相应的链接。例如下图中红色边框圈出的部分。

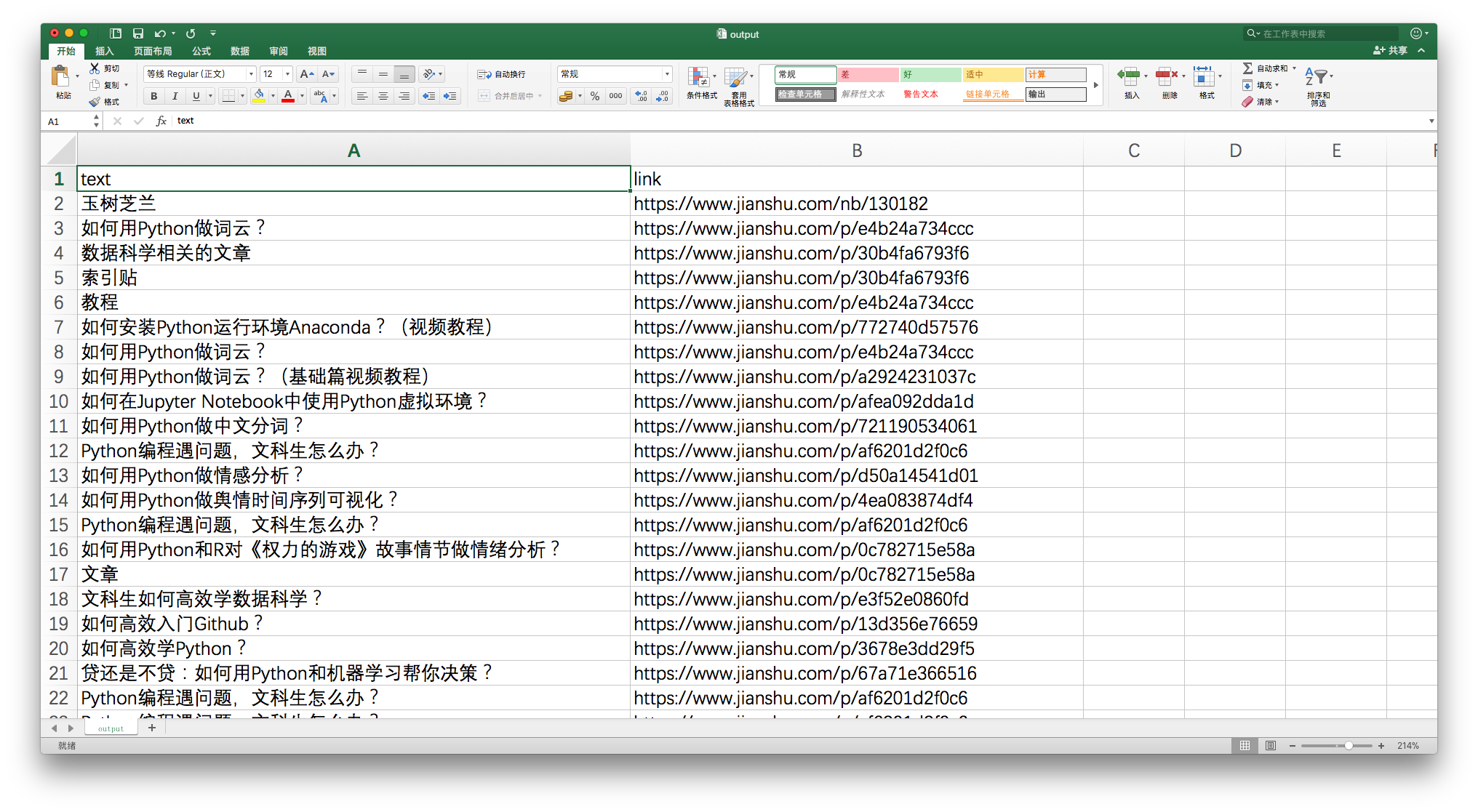

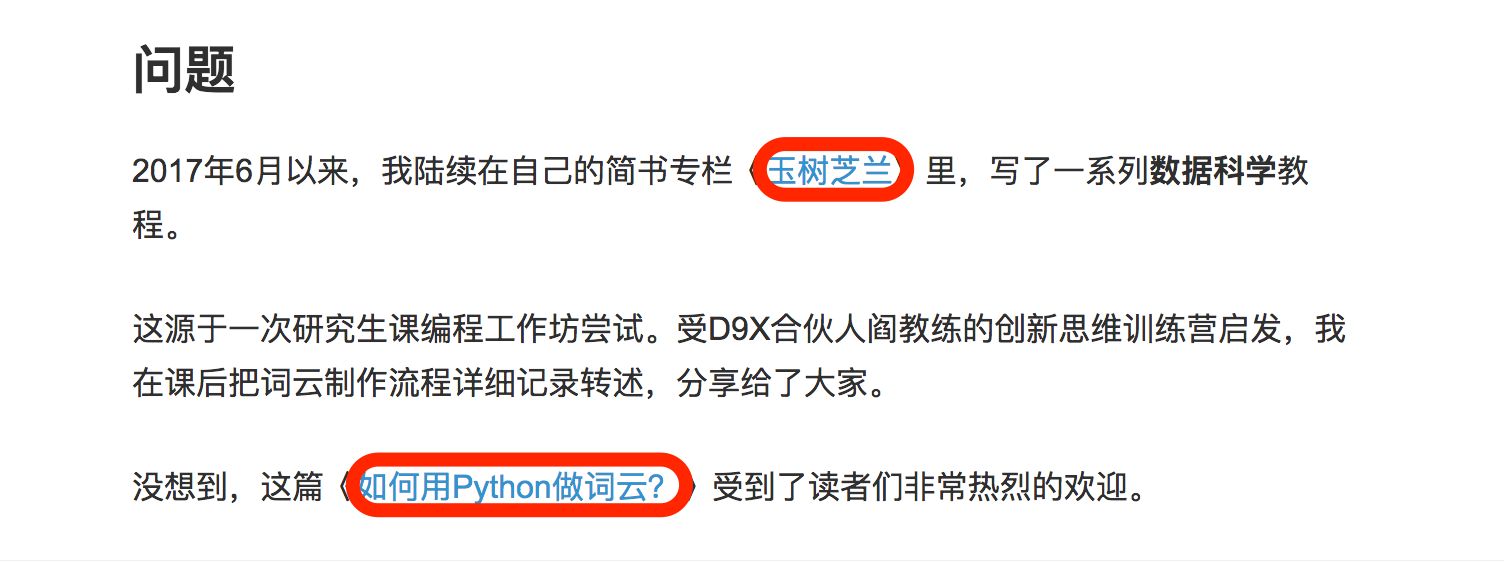

假设你对文中提到的教程感兴趣,想获取这些 文章 链接并将它们存储在 Excel 中,如下所示:

您需要专门提取和存储非结构化的分散信息(自然语言文本中的链接)。

我们对于它可以做些什么呢?

即使不会编程,也可以通读全文,逐一找到这些文章链接,手动复制文章标题和链接,保存在Excel表格中。

但是,这种手动 采集 方法效率不高。

我们使用 Python。

环境

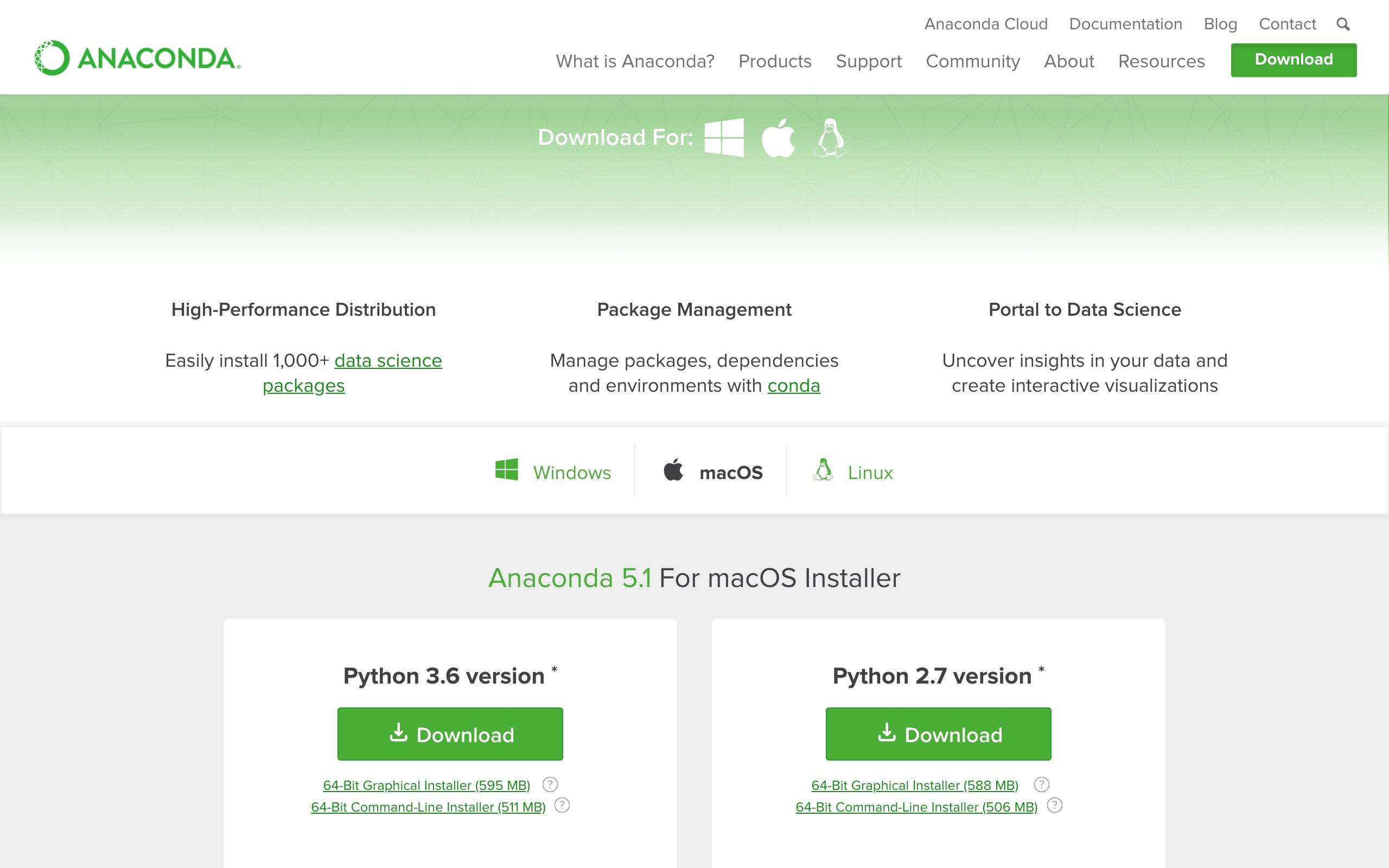

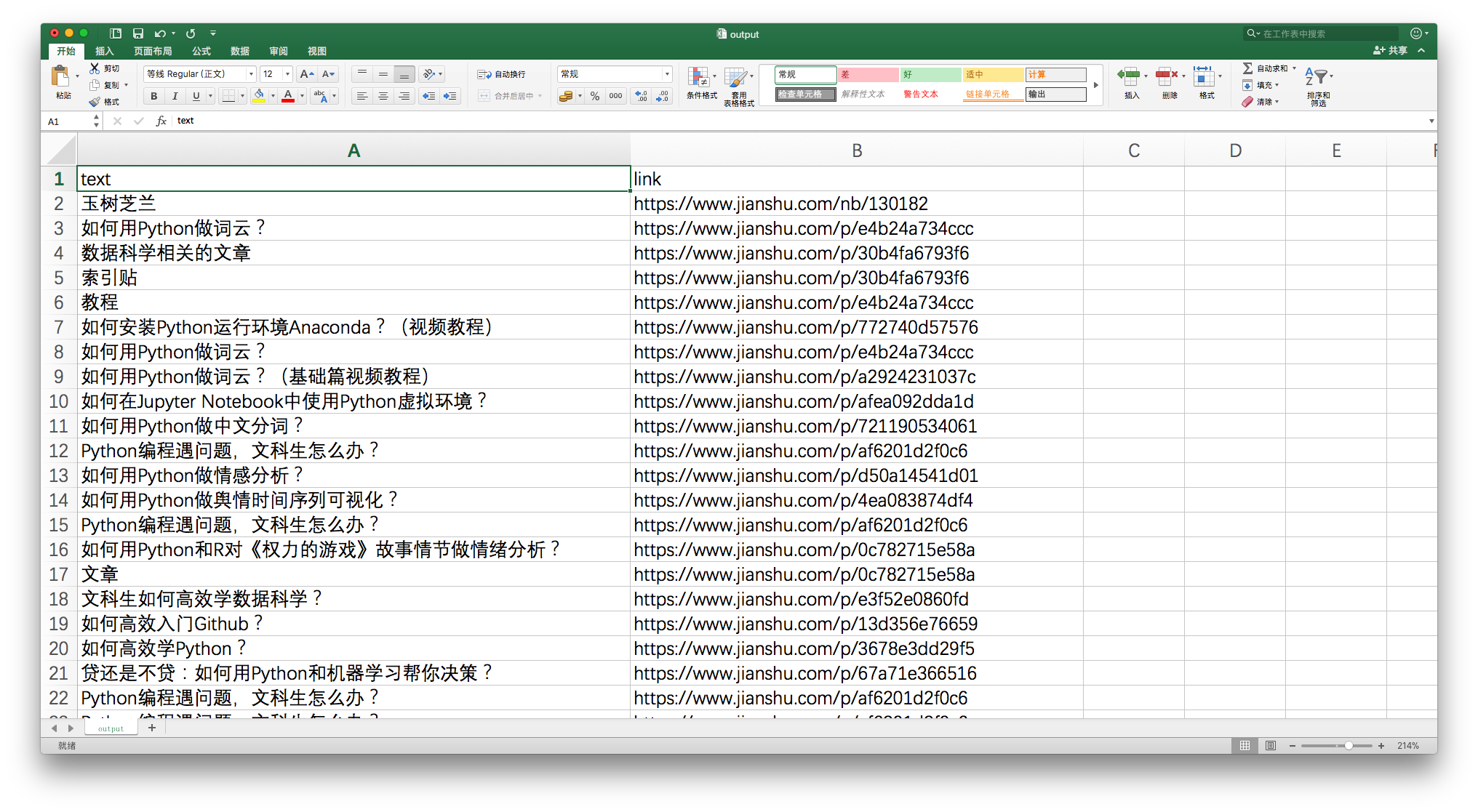

安装 Python 最简单的方法是安装 Anaconda 包。

请到此 URL 下载最新版本的 Anaconda。

请选择左侧 Python 3.6 版本下载安装。

如果您需要具体的分步说明,或者想知道如何在 Windows 上安装和运行 Anaconda 命令,请参考我为您准备的视频教程。

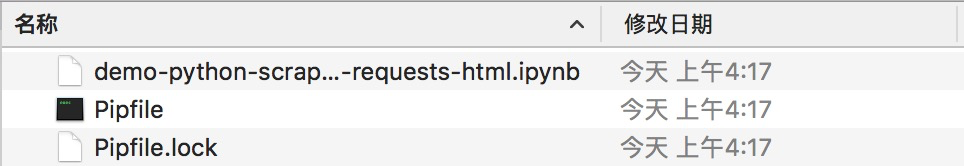

安装 Anaconda 后,请到本网站下载本教程的 zip 包。

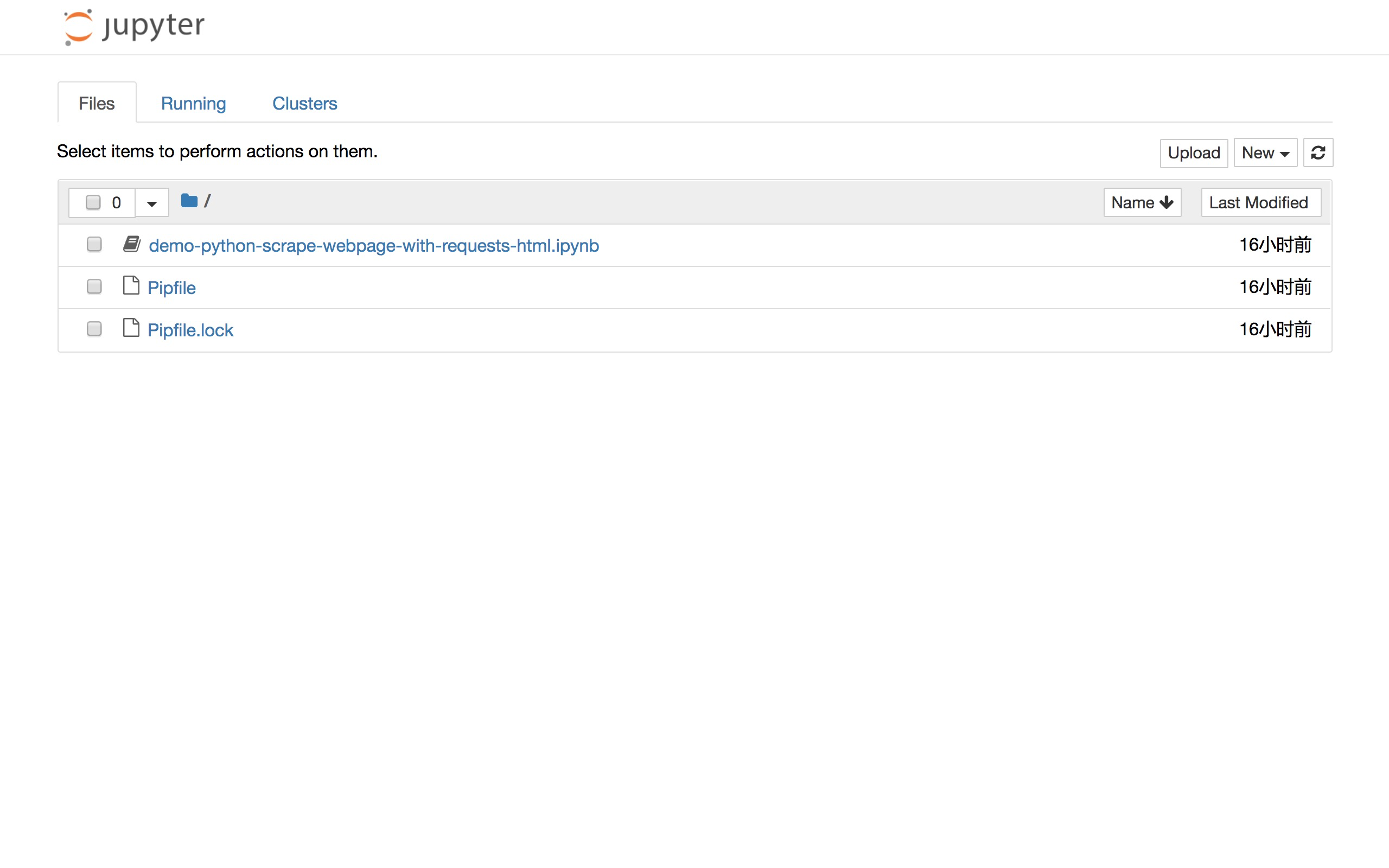

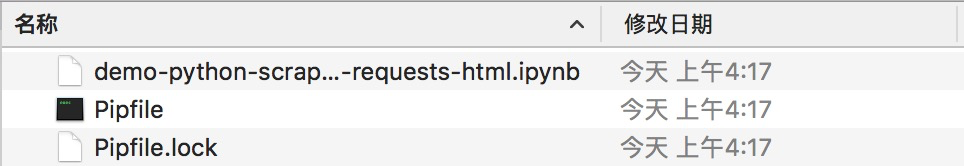

下载解压后,会在生成的目录(以下简称“demo目录”)中看到如下三个文件。

打开终端,使用 cd 命令进入 demo 目录。如果不知道怎么使用,也可以参考视频教程。

我们需要安装一些环境依赖。

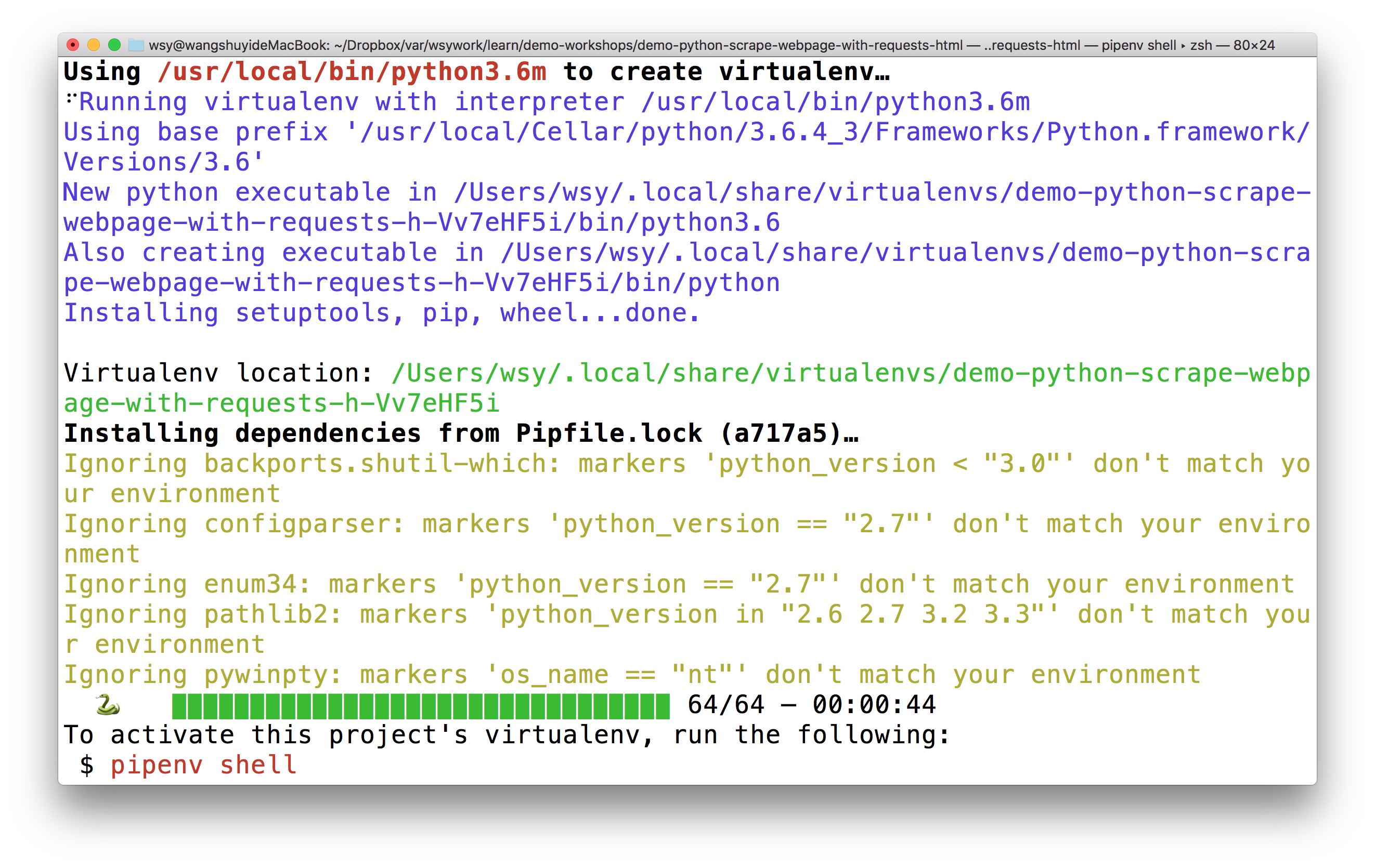

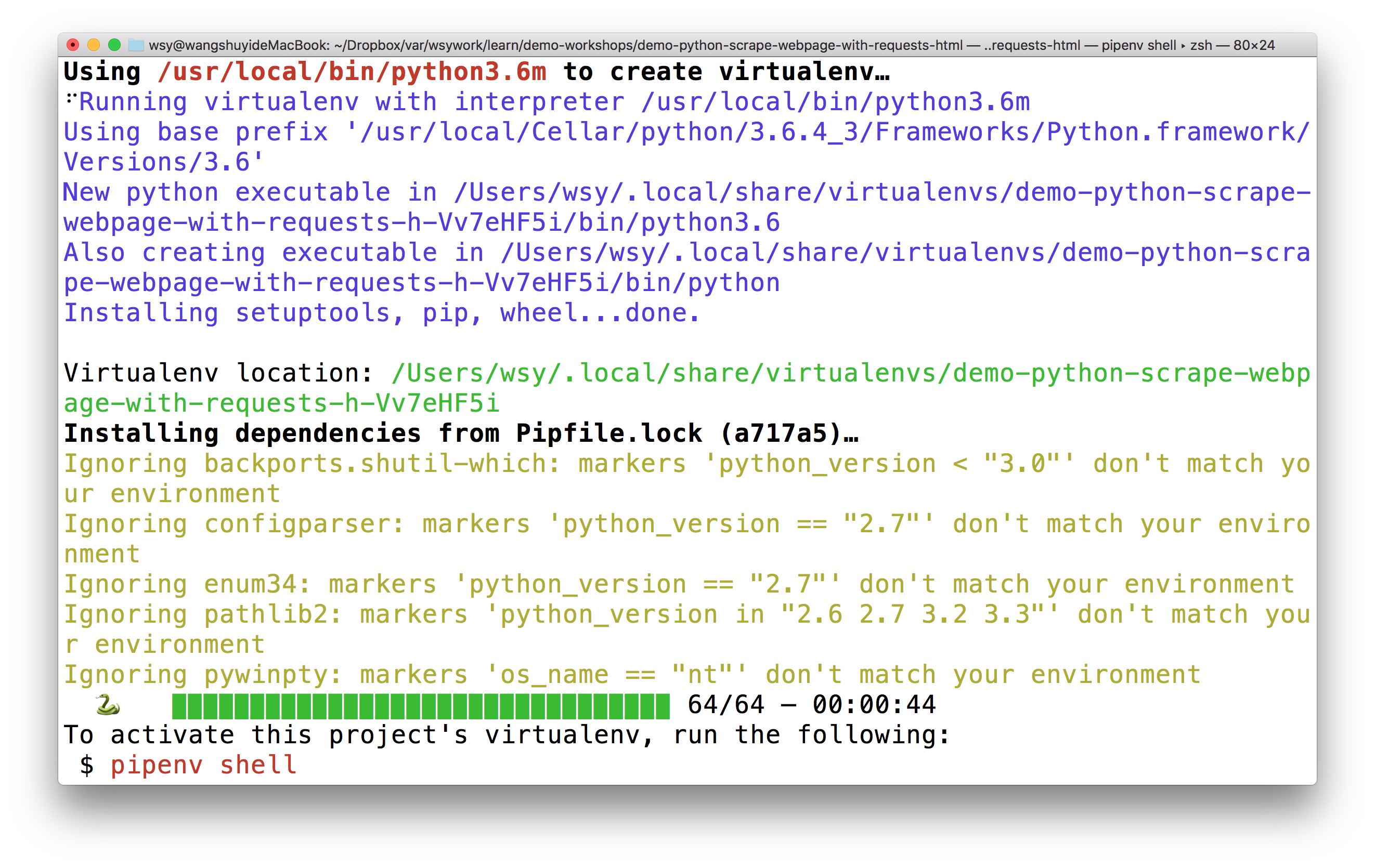

首先执行:

pip install pipenv

这里安装了一个优秀的 Python 包管理工具 pipenv。

安装后执行:

pipenv install

看到 demo 目录下两个 Pipfile 开头的文件了吗?它们是 pipenv 的设置文档。

pipenv 工具会根据它们自动为我们安装所有需要的依赖项。

上图中有一个绿色的进度条,表示要安装的软件数量和实际进度。

安装完成后,按照提示执行:

pipenv shell

请在此处确保您的计算机上安装了 Google Chrome 浏览器。

我们执行:

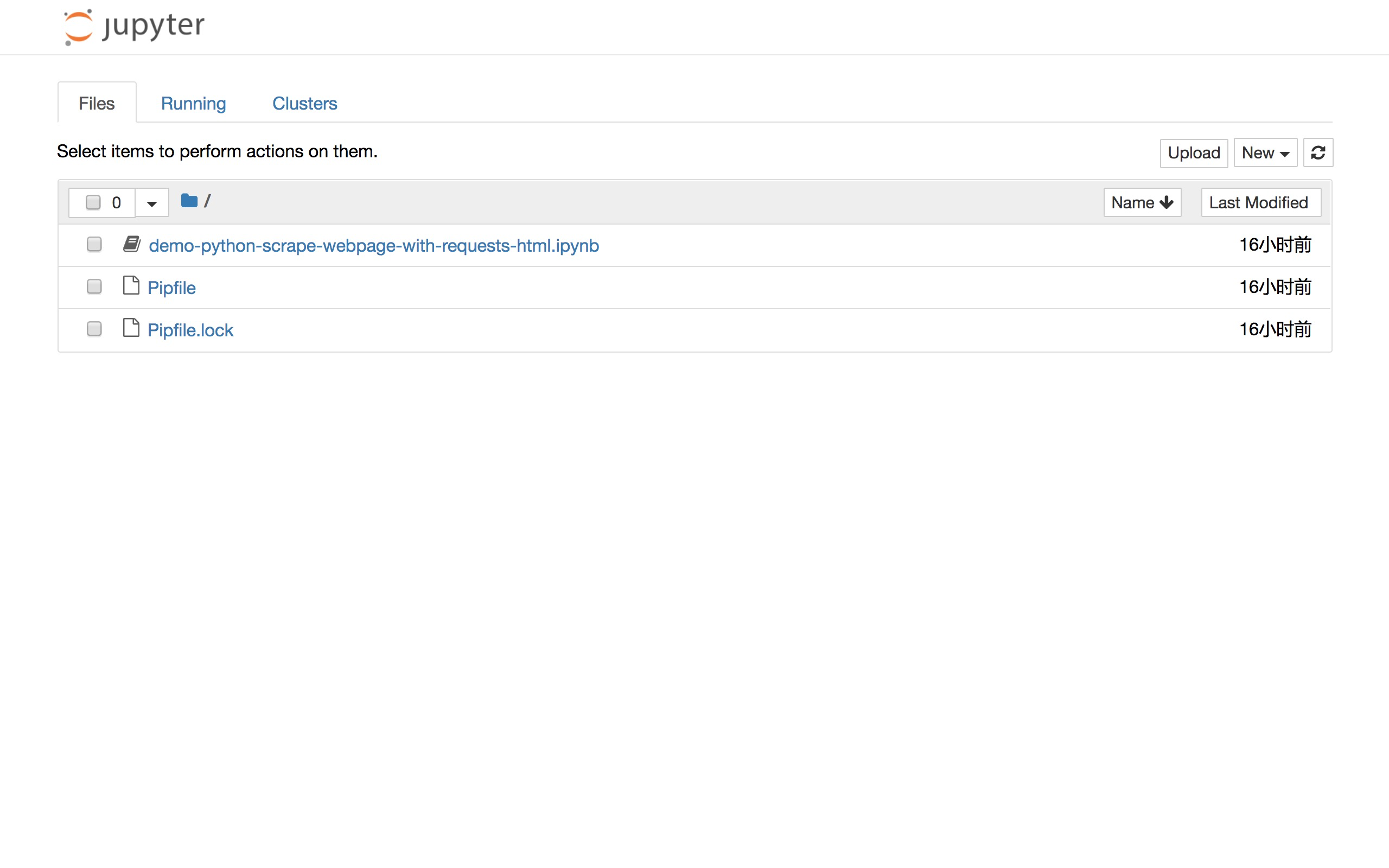

jupyter notebook

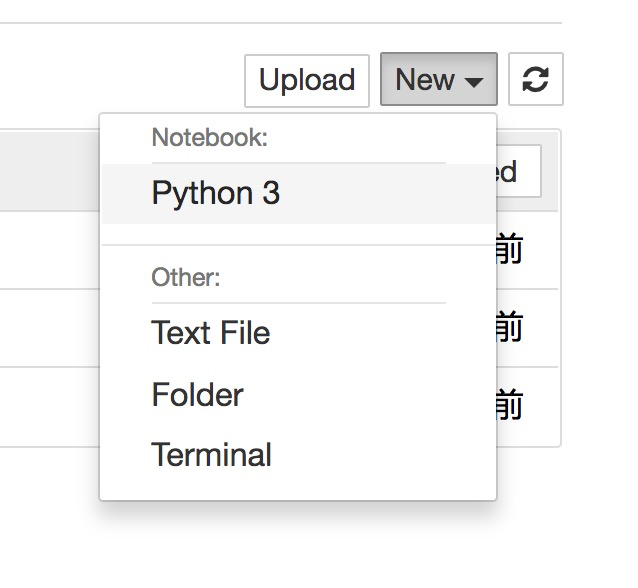

将打开默认浏览器(谷歌浏览器)并启动 Jupyter notebook 界面:

可以直接点击文件列表中的第一个ipynb文件查看本教程的全部示例代码。

您可以在观看教程时一个接一个地执行这些代码。

但是,我推荐的方法是回到主界面并创建一个新的空白 Python 3 笔记本。

请按照教程逐字输入对应的内容。这可以帮助你更深入地理解代码的含义,更有效地内化技能。

准备工作结束了,我们开始正式输入代码。

代码

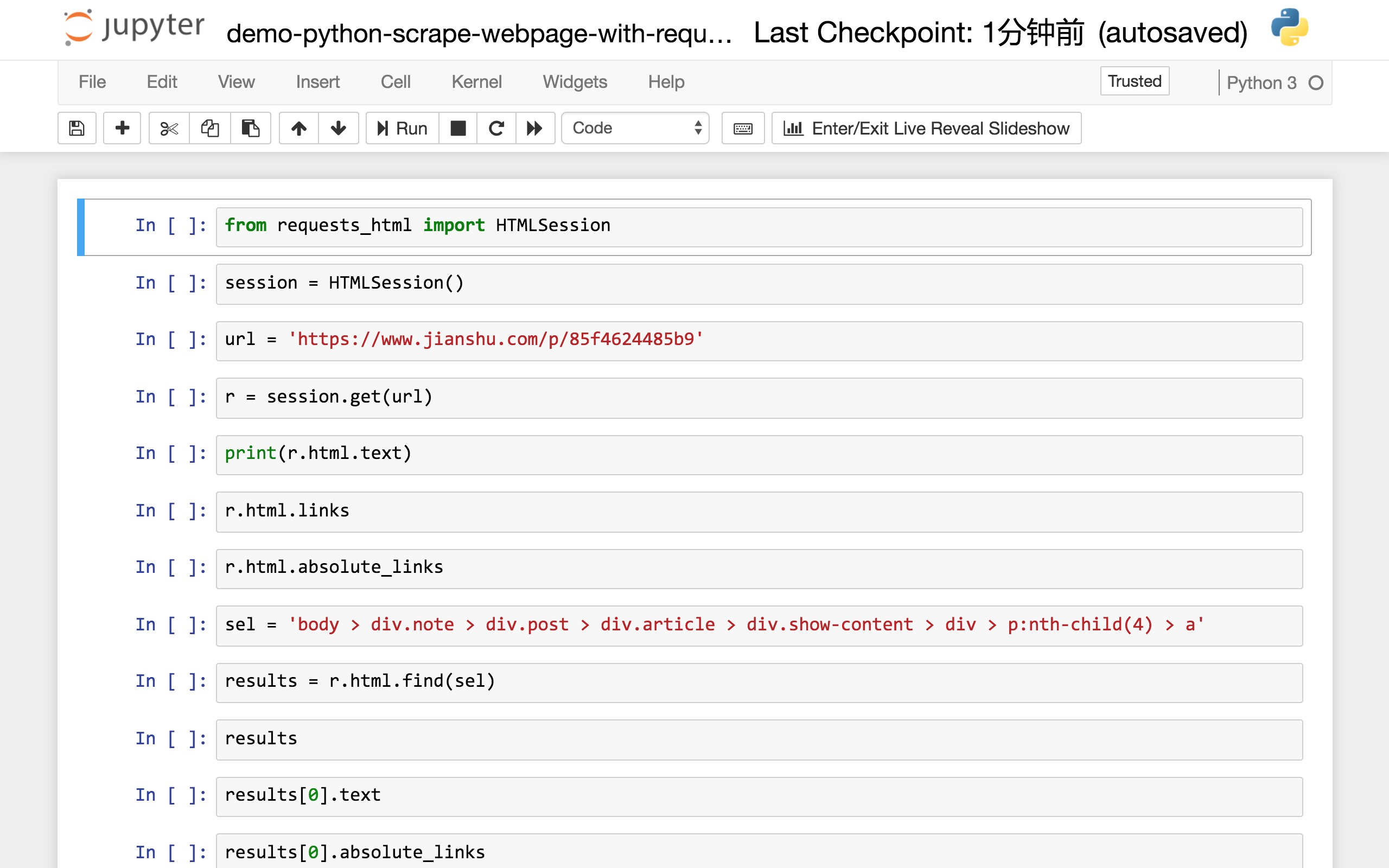

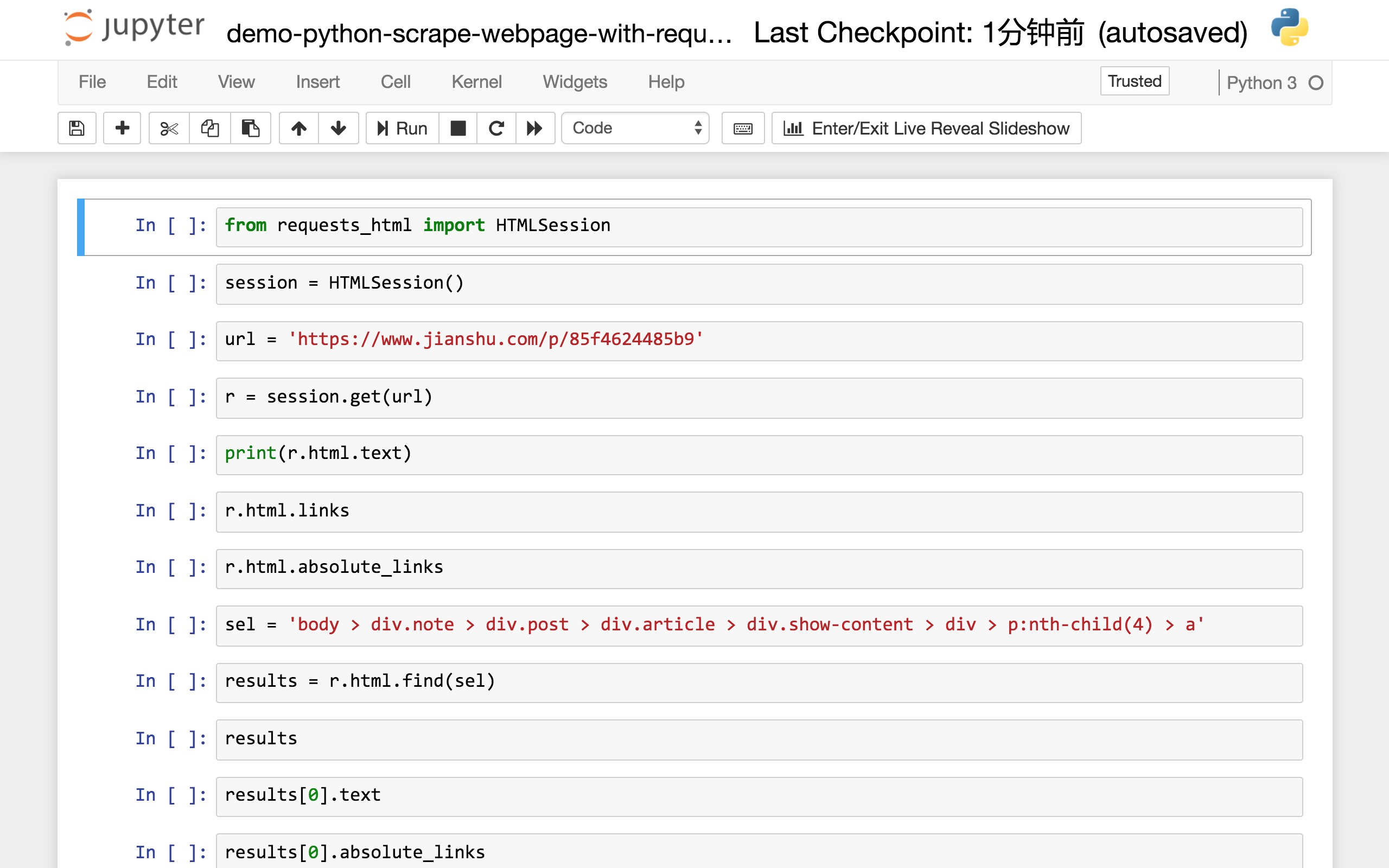

读取网页进行解析和爬取,需要的包是requests_html。我们这里不需要这个包的全部功能,只需阅读其中的 HTMLSession 即可。

from requests_html import HTMLSession

然后,我们建立一个会话(session),也就是让Python充当客户端,与远程服务器对话。

session = HTMLSession()

如前所述,我们打算采集信息的网页是“如何使用“玉树之兰”开始数据科学?”一文。

我们找到它的 URL 并将其存储在 url 变量名中。

url = 'https://www.jianshu.com/p/85f4624485b9'

下面的语句使用session的get函数来获取这个链接对应的整个网页。

r = session.get(url)

页面上有什么?

我们告诉 Python 将服务器返回的内容视为 HTML 文件类型。我不想看 HTML 中乱七八糟的格式描述符,只看文本。

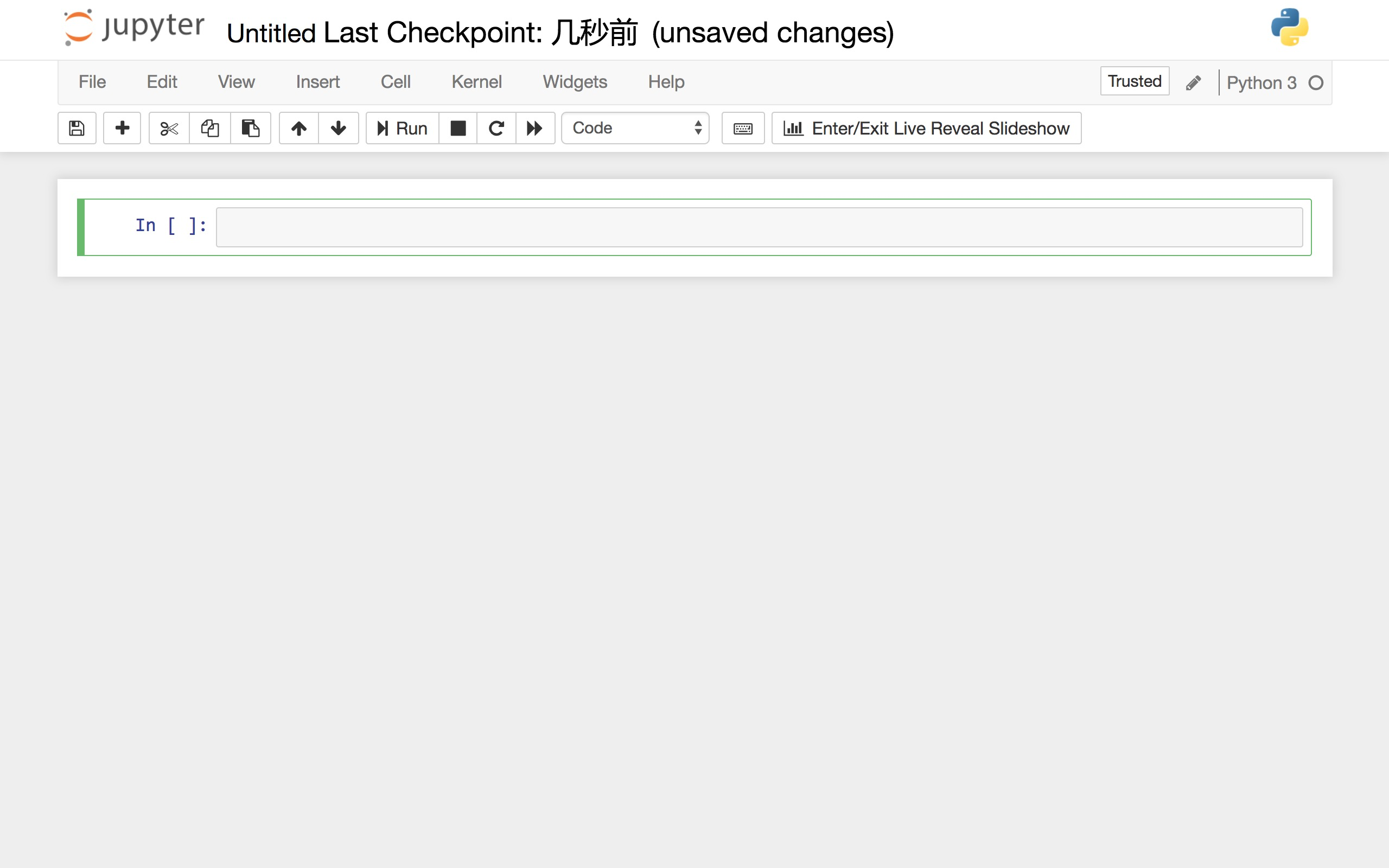

所以我们执行:

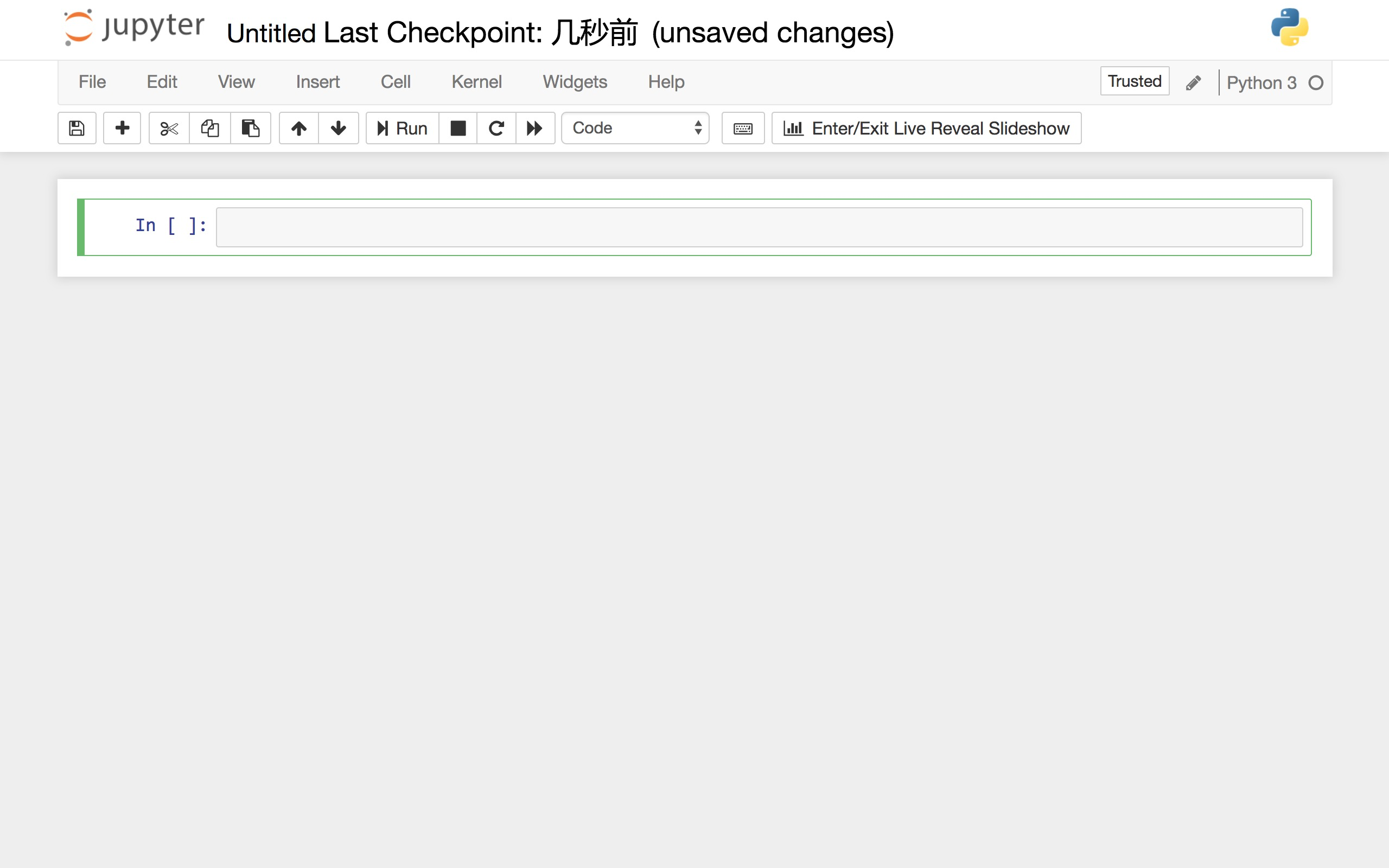

print(r.html.text)

这是得到的结果:

我们心中有它。检索到的网页信息正确,内容完整。

好吧,让我们看看如何接近我们的目标。

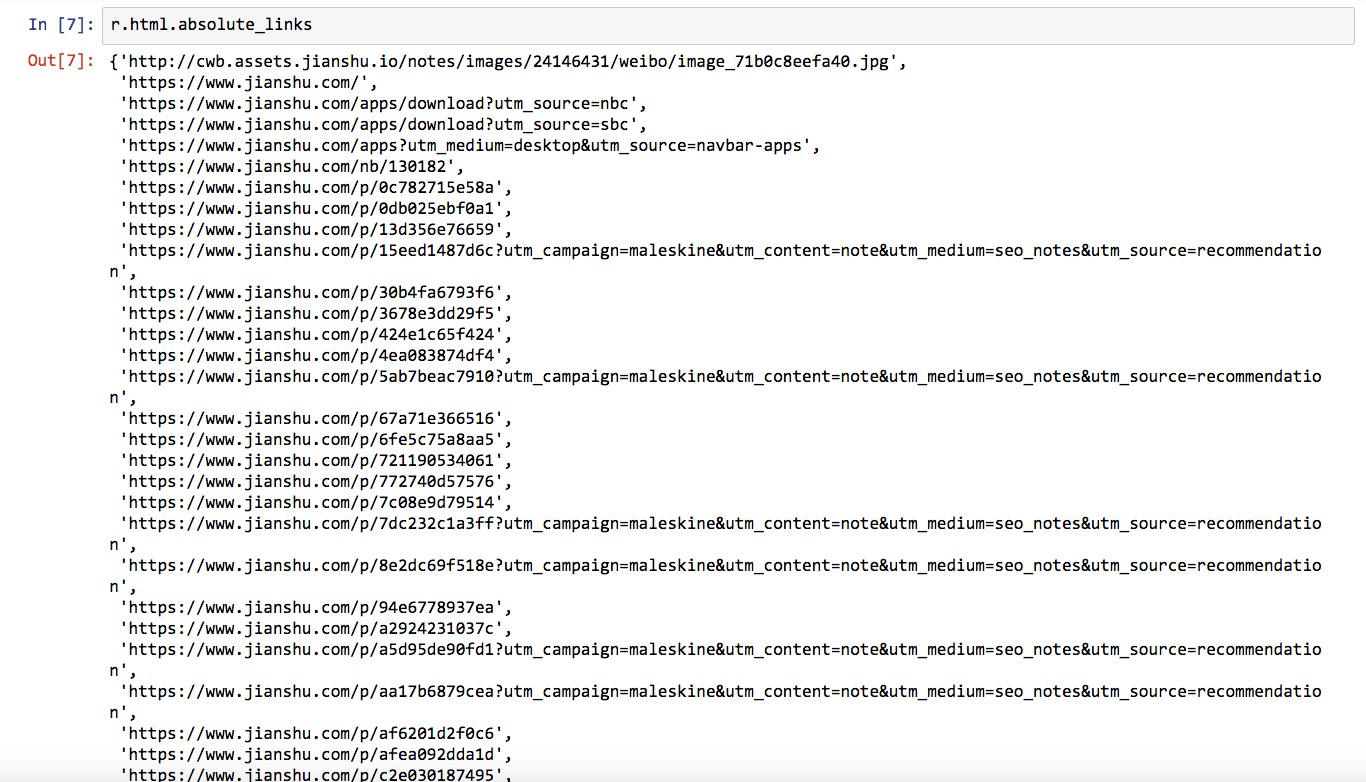

我们首先使用一种简单粗暴的方法来尝试获取网页中收录的所有链接。

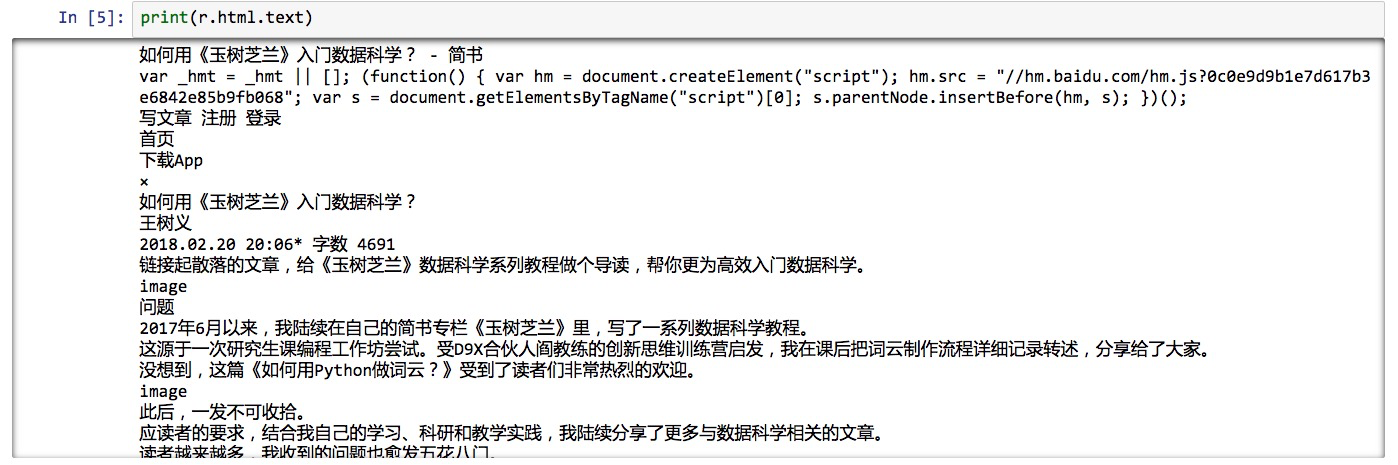

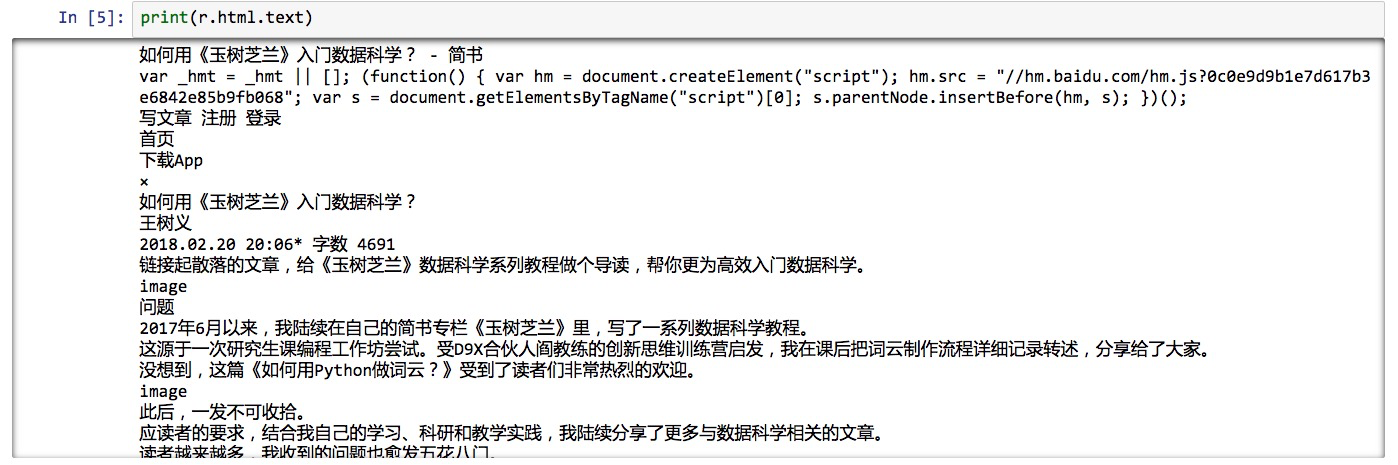

使用返回的内容作为 HTML 文档类型,我们查看 links 属性:

r.html.links

这是返回的结果:

这么多链接!

兴奋的?

然而,你注意到了吗?这里有很多链接,看起来不完整。比如第一个结果,只有:

'/'

这是什么?链接爬错了吗?

不,这种看起来不像链接的东西叫做相对链接。它是一个链接,相对于我们的 采集 网页所在的域名 ( ) 的路径。

这就好比我们在中国寄快递的时候,填表的时候一般会写“XX市,XX省……”,前面就不用加国名了。只有国际快递需要写国名。

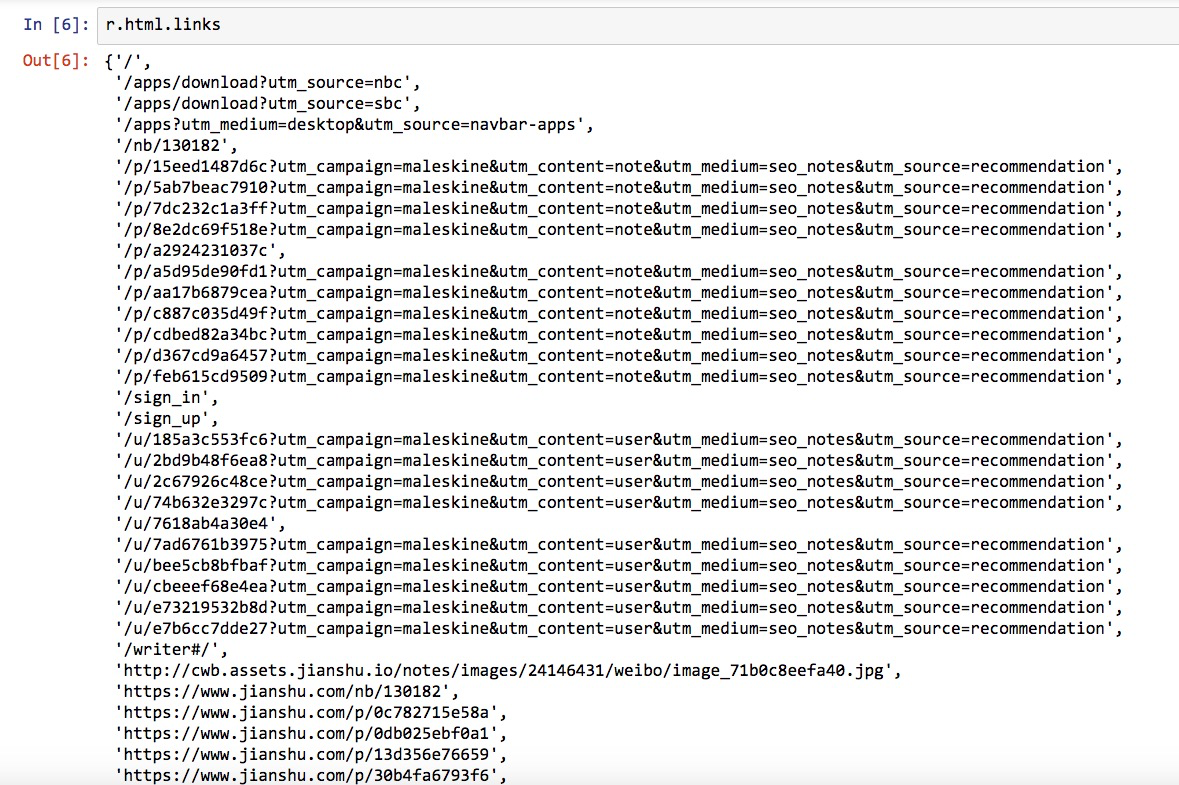

但是,如果我们想获得所有可直接访问的链接怎么办?

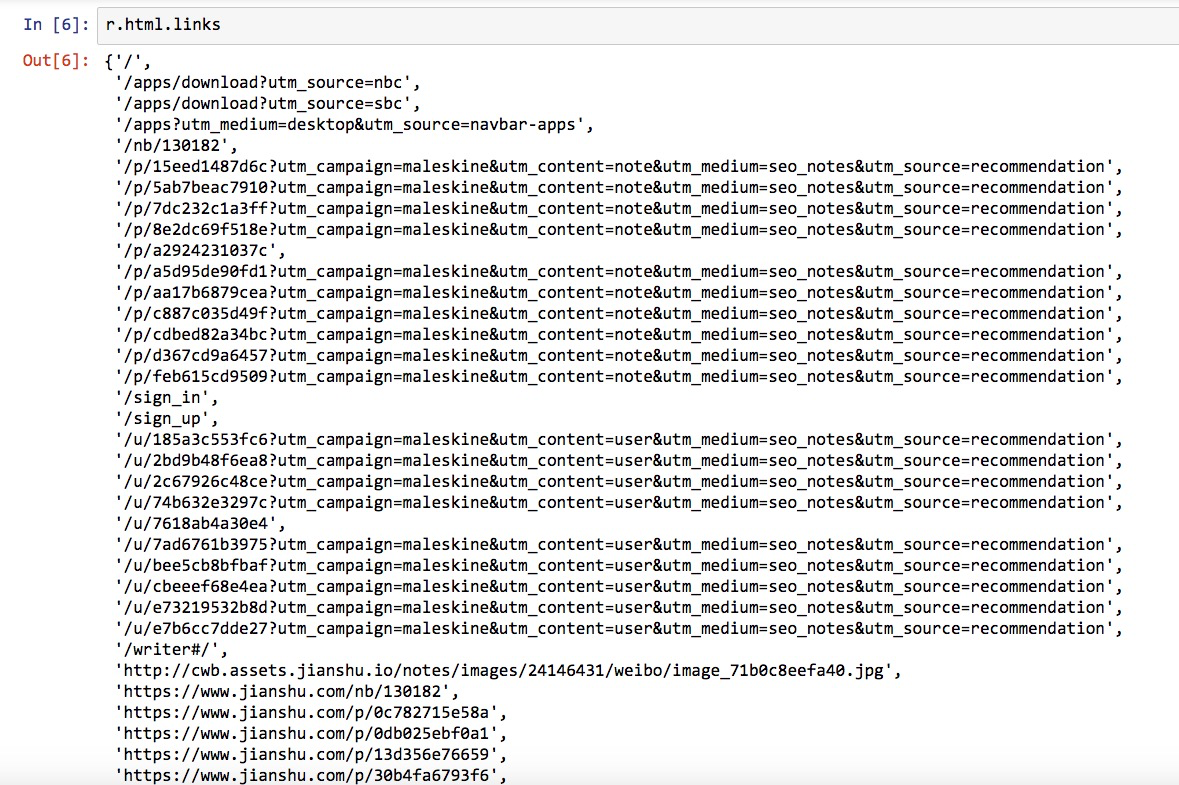

这很简单,只需要一个 Python 语句。

r.html.absolute_links

在这里,我们想要“绝对”链接,所以我们得到以下结果:

这次是不是看起来舒服多了?

我们的使命完成了吗?不是所有的链接都在这里吗?

链接确实在这里,但它与我们的目标不同吗?

检查一下,确实如此。

我们不仅要找到链接,还要找到链接对应的描述文字。是否收录在结果中?

不。

结果列表中的链接是我们所需要的吗?

不。从长度来看,我们可以看出很多链接不是在文本中描述其他数据科学的 URL。

这种直接列出 HTML 文件中所有链接的简单粗暴的方法不适用于此任务。

那么我们应该怎么做呢?

我们必须学会告诉 Python 我们在寻找什么。这是网络抓取的关键。

想一想,如果你想让一个助手(人类)为你做这件事呢?

你会告诉他:

"找到文字中所有可点击的蓝色文字链接,将文字复制到Excel表格中,然后右键复制对应的链接,复制到Excel表格中。每个链接在Excel中占一行,文字和链接每个占用一个单元格。”

虽然这个操作执行起来比较麻烦,但是助手理解之后,就可以帮你执行了。

一样的描述,试着告诉电脑……对不起,它不明白。

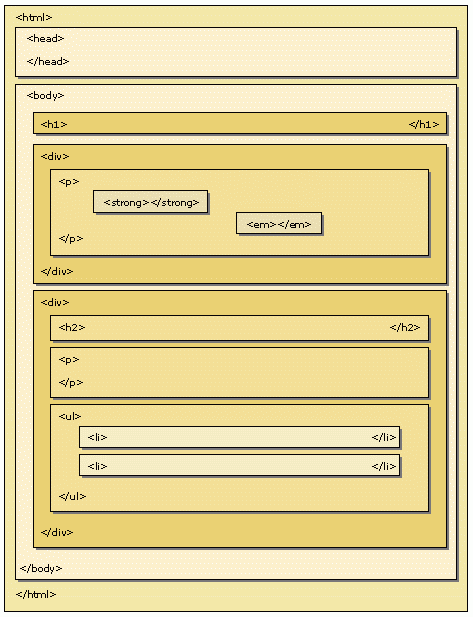

因为你和你的助手看到的网页是这样的。

电脑看到的网页是这样的。

为了让你看清源代码,浏览器还使用颜色来区分不同类型的数据,并对行进行编号。

当数据显示到计算机时,上述辅助视觉功能不可用。它只能看到字符串。

那我们能做什么呢?

仔细看会发现,在这些HTML源代码中,文字和图片链接内容的前后,都会有一些用尖括号括起来的部分,称为“标记”。

HTML 是一种标记语言(HyperText Markup Language)。

标签的目的是什么?它可以将整个文档分解为层。

查看全部

抓取网页数据违法吗(你期待已久的Python网络数据爬虫教程来了。为你演示

)

你期待已久的 Python 网络数据爬虫教程就在这里。本文向您展示了如何从网页中查找感兴趣的链接和描述,并在 Excel 中抓取和存储它们。

需要

我在公众号后台,经常能收到读者留言。

许多评论是读者的问题。只要我有时间,我会尝试回答它。

但是,有些消息乍一看并不清楚。

比如这个:

过了一分钟,他可能觉得不妥(可能是他记起来了,我用简体写了文章),于是又用简体发了一遍。

我恍然大悟。

这位读者以为我的公众号设置了关键词推送对应文章的功能。所以在阅读了我的其他数据科学教程之后,我想看看“爬虫”这个话题。

抱歉,我当时没有写 crawler文章。

而且我的公众号暂时没有设置这种关键词推送。

主要是因为我懒。

这类新闻收到不少,也能体会到读者的需求。不止一位读者对爬虫教程表示了兴趣。

如前所述,目前主流且合法的网络数据采集方式主要分为三类:

前两种方法我已经介绍过了,这次就讲爬虫。

概念

很多读者对爬虫的定义有些混淆。我们需要对其进行分析。

维基百科是这样说的:

网络爬虫,也称为网络蜘蛛,是一种用于自动浏览万维网的网络机器人。它的目的通常是编译一个网络索引。

这就是问题。你不打算成为搜索引擎,那你为什么对网络爬虫如此热衷?

事实上,许多人所说的网络爬虫与另一个功能“网络抓取”相混淆。

在维基百科上,后者是这样解释的:

Web 抓取、Web 采集或 Web 数据提取是用于从网站中提取数据的数据抓取。Web 抓取软件可以使用超文本传输协议或通过 Web 浏览器直接访问万维网。

看不,即使您使用浏览器手动复制数据,也称为网络抓取。你是不是立刻感觉强壮了很多?

但是,这个定义并不完整:

虽然网络抓取可以由软件用户手动完成,但该术语通常是指使用机器人或网络爬虫实现的自动化流程。

换句话说,使用爬虫(或机器人)自动为您完成网络抓取工作是您真正想要的。

你用数据做什么?

通常,它首先存储并放置在数据库或电子表格中以供检索或进一步分析。

所以,你真正想要的功能是:

找到链接,获取网页,抓取指定信息,存储。

这个过程可能会来回走动,甚至滚雪球。

你想自动化它。

知道了这一点,你就可以停止盯着爬虫了。实际上,爬虫是为搜索引擎索引数据库而开发的。为了获取一些数据并使用它,你已经在轰炸蚊子了。

要真正掌握爬虫,你需要有很多基础知识。例如 HTML、CSS、Javascript、数据结构……

这也是我一直犹豫要不要写爬虫教程的原因。

不过这两天看到王朔编辑的一段话,很有启发性:

我喜欢讲一个二十八的替代法则,即投入20%的努力,理解一件事的80%。

既然我们的目标很明确,那就是从网络上抓取数据。那么你需要掌握的最重要的能力就是如何在获得网页链接后快速有效地抓取你想要的信息。

掌握了之后,就不能说你学会了爬行。

但是有了这个基础,您可以比以往更轻松地获取数据。尤其是对于“文科生”的很多应用场景来说,是非常有用的。这是赋权。

此外,进一步了解爬虫的工作原理变得容易得多。

这也是“替代 28 规则”的应用。

Python 语言的重要特性之一是强大的软件工具包的可用性(许多由第三方提供)。您只需要编写一个简单的程序即可自动解析网页并抓取数据。

本文向您展示了该过程。

目标

要抓取网络数据,让我们从一个小目标开始。

目标不能太复杂。但是这样做,它应该可以帮助您了解 Web Scraping。

只需选择我最近发布的一本简短的书文章作为要抓取的对象。题目叫“如何使用《玉树之兰》开始数据科学?”。

在这个文章中,我重新组织并串起了我之前的数据科学系列文章。

文本收录许多以前教程的标题和相应的链接。例如下图中红色边框圈出的部分。

假设你对文中提到的教程感兴趣,想获取这些 文章 链接并将它们存储在 Excel 中,如下所示:

您需要专门提取和存储非结构化的分散信息(自然语言文本中的链接)。

我们对于它可以做些什么呢?

即使不会编程,也可以通读全文,逐一找到这些文章链接,手动复制文章标题和链接,保存在Excel表格中。

但是,这种手动 采集 方法效率不高。

我们使用 Python。

环境

安装 Python 最简单的方法是安装 Anaconda 包。

请到此 URL 下载最新版本的 Anaconda。

请选择左侧 Python 3.6 版本下载安装。

如果您需要具体的分步说明,或者想知道如何在 Windows 上安装和运行 Anaconda 命令,请参考我为您准备的视频教程。

安装 Anaconda 后,请到本网站下载本教程的 zip 包。

下载解压后,会在生成的目录(以下简称“demo目录”)中看到如下三个文件。

打开终端,使用 cd 命令进入 demo 目录。如果不知道怎么使用,也可以参考视频教程。

我们需要安装一些环境依赖。

首先执行:

pip install pipenv

这里安装了一个优秀的 Python 包管理工具 pipenv。

安装后执行:

pipenv install

看到 demo 目录下两个 Pipfile 开头的文件了吗?它们是 pipenv 的设置文档。

pipenv 工具会根据它们自动为我们安装所有需要的依赖项。

上图中有一个绿色的进度条,表示要安装的软件数量和实际进度。

安装完成后,按照提示执行:

pipenv shell

请在此处确保您的计算机上安装了 Google Chrome 浏览器。

我们执行:

jupyter notebook

将打开默认浏览器(谷歌浏览器)并启动 Jupyter notebook 界面:

可以直接点击文件列表中的第一个ipynb文件查看本教程的全部示例代码。

您可以在观看教程时一个接一个地执行这些代码。

但是,我推荐的方法是回到主界面并创建一个新的空白 Python 3 笔记本。

请按照教程逐字输入对应的内容。这可以帮助你更深入地理解代码的含义,更有效地内化技能。

准备工作结束了,我们开始正式输入代码。

代码

读取网页进行解析和爬取,需要的包是requests_html。我们这里不需要这个包的全部功能,只需阅读其中的 HTMLSession 即可。

from requests_html import HTMLSession

然后,我们建立一个会话(session),也就是让Python充当客户端,与远程服务器对话。

session = HTMLSession()

如前所述,我们打算采集信息的网页是“如何使用“玉树之兰”开始数据科学?”一文。

我们找到它的 URL 并将其存储在 url 变量名中。

url = 'https://www.jianshu.com/p/85f4624485b9'

下面的语句使用session的get函数来获取这个链接对应的整个网页。

r = session.get(url)

页面上有什么?

我们告诉 Python 将服务器返回的内容视为 HTML 文件类型。我不想看 HTML 中乱七八糟的格式描述符,只看文本。

所以我们执行:

print(r.html.text)

这是得到的结果:

我们心中有它。检索到的网页信息正确,内容完整。

好吧,让我们看看如何接近我们的目标。

我们首先使用一种简单粗暴的方法来尝试获取网页中收录的所有链接。

使用返回的内容作为 HTML 文档类型,我们查看 links 属性:

r.html.links

这是返回的结果:

这么多链接!

兴奋的?

然而,你注意到了吗?这里有很多链接,看起来不完整。比如第一个结果,只有:

'/'

这是什么?链接爬错了吗?

不,这种看起来不像链接的东西叫做相对链接。它是一个链接,相对于我们的 采集 网页所在的域名 ( ) 的路径。

这就好比我们在中国寄快递的时候,填表的时候一般会写“XX市,XX省……”,前面就不用加国名了。只有国际快递需要写国名。

但是,如果我们想获得所有可直接访问的链接怎么办?

这很简单,只需要一个 Python 语句。

r.html.absolute_links

在这里,我们想要“绝对”链接,所以我们得到以下结果:

这次是不是看起来舒服多了?

我们的使命完成了吗?不是所有的链接都在这里吗?

链接确实在这里,但它与我们的目标不同吗?

检查一下,确实如此。

我们不仅要找到链接,还要找到链接对应的描述文字。是否收录在结果中?

不。

结果列表中的链接是我们所需要的吗?

不。从长度来看,我们可以看出很多链接不是在文本中描述其他数据科学的 URL。

这种直接列出 HTML 文件中所有链接的简单粗暴的方法不适用于此任务。

那么我们应该怎么做呢?

我们必须学会告诉 Python 我们在寻找什么。这是网络抓取的关键。

想一想,如果你想让一个助手(人类)为你做这件事呢?

你会告诉他:

"找到文字中所有可点击的蓝色文字链接,将文字复制到Excel表格中,然后右键复制对应的链接,复制到Excel表格中。每个链接在Excel中占一行,文字和链接每个占用一个单元格。”

虽然这个操作执行起来比较麻烦,但是助手理解之后,就可以帮你执行了。

一样的描述,试着告诉电脑……对不起,它不明白。

因为你和你的助手看到的网页是这样的。

电脑看到的网页是这样的。

为了让你看清源代码,浏览器还使用颜色来区分不同类型的数据,并对行进行编号。

当数据显示到计算机时,上述辅助视觉功能不可用。它只能看到字符串。

那我们能做什么呢?

仔细看会发现,在这些HTML源代码中,文字和图片链接内容的前后,都会有一些用尖括号括起来的部分,称为“标记”。

HTML 是一种标记语言(HyperText Markup Language)。

标签的目的是什么?它可以将整个文档分解为层。

抓取网页数据违法吗(一个文档的主要功能是什么?如何正确的处理技术)

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-01-23 00:07

搜索器的主要作用是根据用户输入的关键词在索引器形成的倒排列表中进行搜索,同时完成页面与搜索的相关性评价,将结果排序为被输出,并实现一定的用户相关反馈机制。

通常通过搜索引擎获得成百上千的检索结果。为了获得有用的信息,一种常用的方法是根据网页的重要性或相关性对网页进行排名,并按照相关性进行排序。这里的相关性是指文档中出现的搜索关键字的数量。当金额较高时,文档被认为更相关。可见性也是常用的指标之一。网页的可见性是指指向网页门户的超链接数量。可见性方法基于这样的思想,即一个网页被其他网页引用的次数越多,它就越有价值。尤其是,一个网页被一个网页引用的越重要,该网页就越重要。结果处理技术可以概括为:

(1)按频率排序,一般来说,一个页面收录的关键词越多,应该与搜索目标越相关,这是一个非常合理的解决方案。

(2)按页面访问量排序在这种方法中,搜索引擎会记录它所搜索的页面被访问的频率。人们访问频率越高的页面应该收录更多的信息,或者具有其他吸引人的优势。这个解决方案适合一般搜索用户,而且由于大部分搜索引擎不是专业用户,所以这个方案也比较适合一般搜索引擎。

(3)二次搜索进一步提纯(相比于flne)结果,根据一定条件优化搜索结果,然后可以选择类别和相关词进行二次搜索等。

由于搜索引擎还不智能,所以排名第一的结果不一定是“最佳”结果,除非您知道要查找的文档的标题。因此,有些文档虽然相关度很高,但不一定是用户最需要的文档。 查看全部

抓取网页数据违法吗(一个文档的主要功能是什么?如何正确的处理技术)

搜索器的主要作用是根据用户输入的关键词在索引器形成的倒排列表中进行搜索,同时完成页面与搜索的相关性评价,将结果排序为被输出,并实现一定的用户相关反馈机制。

通常通过搜索引擎获得成百上千的检索结果。为了获得有用的信息,一种常用的方法是根据网页的重要性或相关性对网页进行排名,并按照相关性进行排序。这里的相关性是指文档中出现的搜索关键字的数量。当金额较高时,文档被认为更相关。可见性也是常用的指标之一。网页的可见性是指指向网页门户的超链接数量。可见性方法基于这样的思想,即一个网页被其他网页引用的次数越多,它就越有价值。尤其是,一个网页被一个网页引用的越重要,该网页就越重要。结果处理技术可以概括为:

(1)按频率排序,一般来说,一个页面收录的关键词越多,应该与搜索目标越相关,这是一个非常合理的解决方案。

(2)按页面访问量排序在这种方法中,搜索引擎会记录它所搜索的页面被访问的频率。人们访问频率越高的页面应该收录更多的信息,或者具有其他吸引人的优势。这个解决方案适合一般搜索用户,而且由于大部分搜索引擎不是专业用户,所以这个方案也比较适合一般搜索引擎。

(3)二次搜索进一步提纯(相比于flne)结果,根据一定条件优化搜索结果,然后可以选择类别和相关词进行二次搜索等。

由于搜索引擎还不智能,所以排名第一的结果不一定是“最佳”结果,除非您知道要查找的文档的标题。因此,有些文档虽然相关度很高,但不一定是用户最需要的文档。

抓取网页数据违法吗(抓取网页数据违法吗?抓住算法是否非法?(上))

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-01-22 12:02

抓取网页数据违法吗?按常规的算法来说显然算法本身就违法,所以有人说抓到抓到算法,也有人说算法无罪,那是因为违法与否是个有待商榷的问题,且关键看抓住算法是否非法?因为对于很多判断来说算法都是可以自定义的,比如某人叫什么名字,当年国内号称国民老公的好多明星,比如某人微博上的抽奖,自己买彩票中过什么号码的奖,等等。

那抓捕算法犯罪的人难道是违法吗?也未必。某人有非法登记没登记是重罪,但某人玩个秒拍的评论出现在某信息化大数据时代的公开网页上,也是违法的。但是且不要轻视算法违法。比如有很多人就通过算法去做刷单,他们通过刷单得到了精准的商品信息,他们之所以去相信这些信息,就是因为他们觉得这个世界上有大量的商品信息可以获取,比如b2b某网站的展示图。

算法违法只是物理方面的。而心理方面和数据方面,对于算法来说要稍微复杂一些。而应对算法算法错误,通常有几种非常有效的措施,比如网站要经常更新算法,经常去更新关键字,去算法提供者算法解释人了解算法并去优化算法,等等。但在实际应用中,可能并不可行。不要去盲目找算法,算法你并不能完全确定是正确的,算法不是唯一的,算法是根据用户的各种行为来进行判断的,但实际应用中,算法通常来说是可以自定义的,就算你网站上挂个公告,算法犯错,但并不是很严重,比如黑产并不会定义这个公告属于算法犯错,而是简单的屏蔽掉不让这个类目出现在黑产页面。

你真正要做的,是通过数据抓取、采集、爬虫等手段,去发现算法的错误点,特别是要发现算法本身是错误的,造成过失的算法。什么算法违法了?要看你是处于哪个目的,是起到批量抓取的效果,还是起到传播点击的效果,还是起到跟踪目标点击的效果。一旦你起到非法点击和无意真正抓取目标流量,那你就违法了。 查看全部

抓取网页数据违法吗(抓取网页数据违法吗?抓住算法是否非法?(上))

抓取网页数据违法吗?按常规的算法来说显然算法本身就违法,所以有人说抓到抓到算法,也有人说算法无罪,那是因为违法与否是个有待商榷的问题,且关键看抓住算法是否非法?因为对于很多判断来说算法都是可以自定义的,比如某人叫什么名字,当年国内号称国民老公的好多明星,比如某人微博上的抽奖,自己买彩票中过什么号码的奖,等等。

那抓捕算法犯罪的人难道是违法吗?也未必。某人有非法登记没登记是重罪,但某人玩个秒拍的评论出现在某信息化大数据时代的公开网页上,也是违法的。但是且不要轻视算法违法。比如有很多人就通过算法去做刷单,他们通过刷单得到了精准的商品信息,他们之所以去相信这些信息,就是因为他们觉得这个世界上有大量的商品信息可以获取,比如b2b某网站的展示图。

算法违法只是物理方面的。而心理方面和数据方面,对于算法来说要稍微复杂一些。而应对算法算法错误,通常有几种非常有效的措施,比如网站要经常更新算法,经常去更新关键字,去算法提供者算法解释人了解算法并去优化算法,等等。但在实际应用中,可能并不可行。不要去盲目找算法,算法你并不能完全确定是正确的,算法不是唯一的,算法是根据用户的各种行为来进行判断的,但实际应用中,算法通常来说是可以自定义的,就算你网站上挂个公告,算法犯错,但并不是很严重,比如黑产并不会定义这个公告属于算法犯错,而是简单的屏蔽掉不让这个类目出现在黑产页面。

你真正要做的,是通过数据抓取、采集、爬虫等手段,去发现算法的错误点,特别是要发现算法本身是错误的,造成过失的算法。什么算法违法了?要看你是处于哪个目的,是起到批量抓取的效果,还是起到传播点击的效果,还是起到跟踪目标点击的效果。一旦你起到非法点击和无意真正抓取目标流量,那你就违法了。

抓取网页数据违法吗(soup标题位于标记中的应用(一)(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-01-20 21:18

)

在类别下,您可以进一步看到标题在标签中,属性是“itemprop”和“标题”,可以使用 .find() 函数访问。

news1=soup.find_all('div',class_=["news-card-title news-right-box"])[0]

title=news1.find('span',attrs={'itemprop':"headline"}).string

print(title)

We get the following outputgiven below-

Shuttler Jayaram wins Dutch OpenGrand Prix

同样,如果您想访问新闻内容,请将新闻设置为

新闻卡内容新闻右框” > 类别。我们还可以看到,新闻正文位于

标签,标签的属性是“itemprop”和“articleBody”,可以使用.find()函数访问。

news1=soup.find_all('div',class_=["news-card-content news-right-box"])[0]

content=news1.find('div',attrs={'itemprop':"articleBody"}).string

print(content)

Indian Shuttler Ajay Jayaramclinched $50k Dutch Open Grand Prix at Almere in Netherlands on Sunday,becoming the first Indian to win badminton Grand Prix tournament under a newscoring system. Jayaram defeated Indonesia's Ihsan Maulana Mustofa 10-11, 11-6,11-7, 1-11, 11-9 in an exciting final clash. The 27-year-old returned to thecircuit in August after a seven-month injury layoff.

以类似的方式,我们可以提取任何信息,如图像、作者姓名、时间等。

第 3 步:创建数据集

接下来,我们对 3 个新闻类别进行此操作,然后将所有 文章 对应的内容和类别存储在一个数据框中。我将使用三个不同的 Url,对每个 URL 执行相同的步骤,并将所有 文章 及其内容设置类别存储为一个列表。

urls=["https://inshorts.com/en/read/cricket","https://inshorts.com/en/read/tennis",

"https://inshorts.com/en/read/badminton"]

news_data_content,news_data_title,news_data_category=[],[],[]

for url in urls:

category=url.split('/')[-1]

data=requests.get(url)

soup=BeautifulSoup(data.content,'html.parser')

news_title=[]

news_content=[]

news_category=[]

for headline,article inzip(soup.find_all('div', class_=["news-card-titlenews-right-box"]),

soup.find_all('div',class_=["news-card-contentnews-right-box"])):

news_title.append(headline.find('span',attrs={'itemprop':"headline"}).string)

news_content.append(article.find('div',attrs={'itemprop':"articleBody"}).string)

news_category.append(category)

news_data_title.extend(news_title)

news_data_content.extend(news_content)

news_data_category.extend(news_category)

df1=pd.DataFrame(news_data_title,columns=["Title"])

df2=pd.DataFrame(news_data_content,columns=["Content"])

df3=pd.DataFrame(news_data_category,columns=["Category"])

df=pd.concat([df1,df2,df3],axis=1)

df.sample(10)

输出是:

您可以看到使用漂亮的汤库在 python 中抓取 Web 信息是多么容易,并且您可以轻松地为任何数据科学项目采集有用的数据。从此,准备好自己的“慧眼”,快速从网页中提取有价值的信息。

查看全部

抓取网页数据违法吗(soup标题位于标记中的应用(一)(图)

)

在类别下,您可以进一步看到标题在标签中,属性是“itemprop”和“标题”,可以使用 .find() 函数访问。

news1=soup.find_all('div',class_=["news-card-title news-right-box"])[0]

title=news1.find('span',attrs={'itemprop':"headline"}).string

print(title)

We get the following outputgiven below-

Shuttler Jayaram wins Dutch OpenGrand Prix

同样,如果您想访问新闻内容,请将新闻设置为

新闻卡内容新闻右框” > 类别。我们还可以看到,新闻正文位于

标签,标签的属性是“itemprop”和“articleBody”,可以使用.find()函数访问。

news1=soup.find_all('div',class_=["news-card-content news-right-box"])[0]

content=news1.find('div',attrs={'itemprop':"articleBody"}).string

print(content)

Indian Shuttler Ajay Jayaramclinched $50k Dutch Open Grand Prix at Almere in Netherlands on Sunday,becoming the first Indian to win badminton Grand Prix tournament under a newscoring system. Jayaram defeated Indonesia's Ihsan Maulana Mustofa 10-11, 11-6,11-7, 1-11, 11-9 in an exciting final clash. The 27-year-old returned to thecircuit in August after a seven-month injury layoff.

以类似的方式,我们可以提取任何信息,如图像、作者姓名、时间等。

第 3 步:创建数据集

接下来,我们对 3 个新闻类别进行此操作,然后将所有 文章 对应的内容和类别存储在一个数据框中。我将使用三个不同的 Url,对每个 URL 执行相同的步骤,并将所有 文章 及其内容设置类别存储为一个列表。

urls=["https://inshorts.com/en/read/cricket","https://inshorts.com/en/read/tennis",

"https://inshorts.com/en/read/badminton"]

news_data_content,news_data_title,news_data_category=[],[],[]

for url in urls:

category=url.split('/')[-1]

data=requests.get(url)

soup=BeautifulSoup(data.content,'html.parser')

news_title=[]

news_content=[]

news_category=[]

for headline,article inzip(soup.find_all('div', class_=["news-card-titlenews-right-box"]),

soup.find_all('div',class_=["news-card-contentnews-right-box"])):

news_title.append(headline.find('span',attrs={'itemprop':"headline"}).string)

news_content.append(article.find('div',attrs={'itemprop':"articleBody"}).string)

news_category.append(category)

news_data_title.extend(news_title)

news_data_content.extend(news_content)

news_data_category.extend(news_category)

df1=pd.DataFrame(news_data_title,columns=["Title"])

df2=pd.DataFrame(news_data_content,columns=["Content"])

df3=pd.DataFrame(news_data_category,columns=["Category"])

df=pd.concat([df1,df2,df3],axis=1)

df.sample(10)

输出是:

您可以看到使用漂亮的汤库在 python 中抓取 Web 信息是多么容易,并且您可以轻松地为任何数据科学项目采集有用的数据。从此,准备好自己的“慧眼”,快速从网页中提取有价值的信息。

抓取网页数据违法吗(有几种方法可以检查被阻止的爬网程序:要么)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-01-18 23:03

当我们第一次接触python爬虫时,总是遇到采集data时爬虫被阻塞的问题。我想每个人都有类似的问题。今天我们将从http代理ip的角度来讨论如何解决这个问题。使用代理 IP 服务器抓取网页时,我的 IP 是否仍会被阻止?

一般来说,有几种方法可以检查被阻止的爬虫:

首先,检查 JavaScript。如果您从 Web 服务器收到的页面是空白的、缺少信息,或者遇到了您不期望的(或您在浏览器中看到的),可能是因为 网站 创建的页面有问题使用 JavaScript 执行。

二、看普通浏览器提交的参数。如果您打算向 网站 提交表单或 POST 请求,请记得检查页面内容以查看您提交的每个字段是否填写正确且格式正确。使用 Chrome 的 web 面板(快捷键 F12 打开开发者控制台,然后单击“网络”查看)查看发送到 网站 的 POST 命令,并确保您的每个参数都正确。

第三,是否有合法的cookies?如果您已经登录到 网站 但无法保持登录状态,或者如果您在 网站 上有其他“登录状态”异常,请检查您的 cookie。确保在每次页面加载时正确调用 cookie,并且每次发出请求时将 cookie 发送到 网站。

四、IP被封了吗?如果您在客户端收到 HTTP 错误,尤其是 403 Forbidden 错误,这可能表明 网站 已将您的 IP 视为机器人并且不再接受您的任何请求。等待您的 IP 地址从 网站 黑名单中删除,或更改 IP 地址。如果您确定自己没有被禁止,请查看以下内容。

第五,确保你的爬虫在 网站 上不会太快。快速采集是一个坏习惯,它会给网络管理员的服务器带来沉重的负担,让你陷入违法的境地。这也是IP被网站列入黑名单的主要原因。为您的爬虫增加延迟,让它们在深夜运行。请记住:匆忙编写程序或采集数据是项目管理不善的标志;我们应该提前计划以避免恐慌。

第六,还必须做一件事:修改你的请求头!一些 网站 会阻止任何自称爬行动物的访客。如果您不确定请求标头的值是否合适,请使用您浏览器的请求标头。 查看全部

抓取网页数据违法吗(有几种方法可以检查被阻止的爬网程序:要么)

当我们第一次接触python爬虫时,总是遇到采集data时爬虫被阻塞的问题。我想每个人都有类似的问题。今天我们将从http代理ip的角度来讨论如何解决这个问题。使用代理 IP 服务器抓取网页时,我的 IP 是否仍会被阻止?

一般来说,有几种方法可以检查被阻止的爬虫:

首先,检查 JavaScript。如果您从 Web 服务器收到的页面是空白的、缺少信息,或者遇到了您不期望的(或您在浏览器中看到的),可能是因为 网站 创建的页面有问题使用 JavaScript 执行。

二、看普通浏览器提交的参数。如果您打算向 网站 提交表单或 POST 请求,请记得检查页面内容以查看您提交的每个字段是否填写正确且格式正确。使用 Chrome 的 web 面板(快捷键 F12 打开开发者控制台,然后单击“网络”查看)查看发送到 网站 的 POST 命令,并确保您的每个参数都正确。

第三,是否有合法的cookies?如果您已经登录到 网站 但无法保持登录状态,或者如果您在 网站 上有其他“登录状态”异常,请检查您的 cookie。确保在每次页面加载时正确调用 cookie,并且每次发出请求时将 cookie 发送到 网站。

四、IP被封了吗?如果您在客户端收到 HTTP 错误,尤其是 403 Forbidden 错误,这可能表明 网站 已将您的 IP 视为机器人并且不再接受您的任何请求。等待您的 IP 地址从 网站 黑名单中删除,或更改 IP 地址。如果您确定自己没有被禁止,请查看以下内容。

第五,确保你的爬虫在 网站 上不会太快。快速采集是一个坏习惯,它会给网络管理员的服务器带来沉重的负担,让你陷入违法的境地。这也是IP被网站列入黑名单的主要原因。为您的爬虫增加延迟,让它们在深夜运行。请记住:匆忙编写程序或采集数据是项目管理不善的标志;我们应该提前计划以避免恐慌。

第六,还必须做一件事:修改你的请求头!一些 网站 会阻止任何自称爬行动物的访客。如果您不确定请求标头的值是否合适,请使用您浏览器的请求标头。

抓取网页数据违法吗(“酷米客”和“车来了”——实时公交APP)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-01-17 16:23

导读:近日,一场关于爬虫和反爬虫的官司再次被推向公众。

本文经授权转自公众号CSDN(ID:CSDNnews),作者郭锐

作为互联网从业者必备的通勤工具之一,公共交通是出行领域的必备。实时公交APP也成为热门应用场景。它们不仅可以为用户提供定位、公交路线查询等信息,还涉及路线规划、公交信息实时地理位置等服务。其中,“Kumike”和“车来”是大众经常使用的两款实时公交出行APP。

01《车来了》指使5名程序员爬取实时公交数据,构成犯罪行为

2012年10月,Kumike实时公交APP上线。通过在公交车上安装定位器,久米科获得了大量实时公交车位置数据,具有定位精度高、实时误差小等明显优势,迅速吸引了大量市场用户。目前,Kumike APP注册量超过5000万,日活跃用户超过400万。

然而,2015年11月,为了提高市场占有率和信息查询的准确性,同样是实时公交APP的“车来”居然指导5名程序员和员工使用爬虫软件获取公交Kumic公司服务器的行车信息。、到达时间等实时数据。

令人惊奇的是,五位程序员分工非常明确:一位负责编写爬虫软件程序;另一位负责编写爬虫软件程序;一是负责不断更改爬虫软件程序中的IP地址,防止被检测到;一个使用不同的IP地址集和爬虫。程序向Kumike发送数据请求;一个负责破解Kumike客户端的加密算法;破解失败后,另一名员工聘请其他公司的技术人员帮助破解加密系统,使爬虫工作得以顺利实施。

这一系列数据操作取得了显著成效,帮助“车来”获取了大量实时久米克数据,每天可达3-4百万条。

花费大量人力、时间和经济成本获得的信息被同行窃取,直接挤压了自身的竞争优势和交易机会。久木怎么能和解?

2016 年,久米克一怒之下将这辆车告上法庭。这场争端花了两年时间才最终得到解决。今年5月,法院裁定车来应立即停止获取和使用久米克实时公交位置数据的不正当竞争行为,并赔偿其经济损失。

想必看到这里,大家最关心的问题就是五名程序员会不会被定罪?尽管在诉讼过程中,五名程序员的员工第二次使用网络爬虫获取公交车车辆的实时信息,只是因为他们履行了本职工作,并未用于谋取私利。但是,Kumike 后端服务器中存储的数据具有巨大的商业价值。未经其许可,任何人不得非法获取软件后台数据并将其用于商业行为——因此必须承担连带责任。

对此,中关村大数据联盟副秘书长陈新和先生表示,“数据爬虫的非法边界一直是互联网争议的热点,尤其是在大数据时代,随着越来越突出的内容数据的价值,爬虫侵权案件越来越多。” 身处其中的程序员很难置身于上级发出的“爬虫需求”之外,一不小心就有可能入局。

02 爬虫类犯罪认定仍不明朗,仍处于灰色地带

事实上,爬虫类犯罪一直是一个难以界定的灰色地带。

网络爬虫是一种自动获取网页内容的程序。通常,这并不违法。比如百度搜索,很多人用的,除了自己的百度知道、百度百科等,几乎都是爬虫采集down。作为一项技术,爬虫本身并不违法,因此在大多数情况下都可以放心使用。一般来说,常见的爬虫方法包括构造合理的HTTP请求头、设置cookie、降低访问频率、隐式输入字段值、使用代理等。

例如,大数据(ID:hzdashuju)、CSDN等平台此前分享了北京二手房数据、网易云音乐评论、马蜂窝旅游数据、大众点评、福利3D信息等应用数据爬取。但并不是所有数据都有“爬墙机会”,陈新和说,“能不能不爬,能不能越界爬,能不能用技术手段越过封锁……这些打擦边球的爬虫?很容易错过目标。” ——尤其是当网站明确声明爬行动物 采集 或禁止转载用于商业化,或者当 网站 声明机器人协议时。

Robots协议又称爬虫协议、机器人协议,全称是“Robots Exclusion Protocol”。网站通过Robots协议告诉爬虫哪些页面可以爬取,哪些页面禁止爬取。

机器人协议是搜索引擎行业公认的商业道德,应予以遵守。

尽管如此,仍有无数“勇者”尝试过自己的风险,包括我们熟悉的百度、360搜索、大众点评、今日头条等:

事实上,可以预见的是,由于目前监管法律的不完善,仍有不少鱼漏网之鱼。但随着数据价值的不断挖掘,未来爬虫侵权案件只会越来越多。

03 第三方网站应该如何应对日益猖獗的爬虫行为?

面对日益猖獗的爬虫行为,作为网站党的你应该如何应对?

既然有“爬虫”,自然就有“反爬虫”。网站常用的反爬虫技术可以分为四类:通过User-Agent控制访问、通过IP限制反爬虫、通过JS脚本阻止爬虫、通过robots.txt限制爬虫。

下面我们通过几个热门网站来分析常见的反爬机制:

1. 豆瓣

很多新爬虫都会爬豆瓣练手,但豆瓣也不是完全豁达。其反爬机制如下:

可以看出,豆瓣对于新爬虫来说是一个非常体贴的网站。只要爬虫在代码中登录账号,减少并发数,然后随机延迟等待一段时间,爬虫程序就不会被阻塞。

2. 拉钩网

拉狗网原来的反爬机制没有现在那么严格,但是随着关注者的增加,网站管理员增加了一些保护服务器的手段。网站的反爬机制如下:

对于这样的爬虫机制,爬虫只能使用IP代理池进行突围。

3. 汽车之家

汽车之家论坛的反爬机制比较先进。它采用前端页面自定义字体的方式,实现反爬的技术手段。具体来说,CSS3中的自定义字体模块用于将自定义Web字体嵌入到指定的网页中。这导致在抓取论坛帖子的口碑时,返回的文本中每隔几个单词就会出现一个乱码。

每次访问论坛页面,字体不变,但字符编码发生变化。因此,爬虫需要根据每次访问动态解析字体文件。具体来说,需要先访问爬取的页面,获取字体文件的动态访问地址,下载字体,读取JS渲染的文本内容,将自定义的字体编码替换为实际的文本编码,再将网页恢复为页面上看到的内容。.

……

然而,反爬虫并不是万能的。“以保护用户数据为名,全面禁止数据垄断爬取的策略,也将受到数据经济时代新反垄断法的挑战。” 陈新和说。

04 程序员如何在数据爬取中“不碍事”?

然而,技术是无罪的,那么程序员应该有罪吗?按照上级的指示写了几行代码,你就莫名被关起来了?可怕的是,他不仅傻眼,而且还无处申诉。

在知乎上,关于爬虫犯罪的问题也不少。在“爬行动物合法还是非法?”的问题下 ()、知乎user@pen核心设计师表示,爬虫开发者的道德自给和经营者的良知是避免触碰法律底线的根本所在:

我们周围的网络已经密密麻麻地布满了各种网络爬虫。作为爬虫开发者,如何避免在使用爬虫时陷入困境的厄运?

严格遵守网站设定的Robots协议;在规避反爬措施的同时,需要优化自己的代码,避免干扰被访问的网站的正常运行;在设置抓取策略时,要注意编码抓取 抓取可能构成视频、音乐等作品的数据,或者针对某些特定的网站批量抓取用户生成的内容;在使用和传播捕获的信息时,应对捕获的内容进行审核,如发现属于用户的个人信息、隐私或他人商业秘密,应及时停止并删除。

因此,面对来自上级的危险爬虫请求,程序员应该采取良好的措施。

对于涉及法律风险的数据爬取需求,程序员最好在采集之前和上级进行一次深入的交谈,并给上级简单介绍一下所涉及的法律风险。如果对方仍然坚持采集,建议提前与公司签订免责协议,避免风险出现时被拉入水中。

参考:

本文经授权转自公众号CSDN(ID:CSDNnews),作者郭锐

问:科技有罪还是无罪? 查看全部

抓取网页数据违法吗(“酷米客”和“车来了”——实时公交APP)

导读:近日,一场关于爬虫和反爬虫的官司再次被推向公众。

本文经授权转自公众号CSDN(ID:CSDNnews),作者郭锐

作为互联网从业者必备的通勤工具之一,公共交通是出行领域的必备。实时公交APP也成为热门应用场景。它们不仅可以为用户提供定位、公交路线查询等信息,还涉及路线规划、公交信息实时地理位置等服务。其中,“Kumike”和“车来”是大众经常使用的两款实时公交出行APP。

01《车来了》指使5名程序员爬取实时公交数据,构成犯罪行为

2012年10月,Kumike实时公交APP上线。通过在公交车上安装定位器,久米科获得了大量实时公交车位置数据,具有定位精度高、实时误差小等明显优势,迅速吸引了大量市场用户。目前,Kumike APP注册量超过5000万,日活跃用户超过400万。

然而,2015年11月,为了提高市场占有率和信息查询的准确性,同样是实时公交APP的“车来”居然指导5名程序员和员工使用爬虫软件获取公交Kumic公司服务器的行车信息。、到达时间等实时数据。

令人惊奇的是,五位程序员分工非常明确:一位负责编写爬虫软件程序;另一位负责编写爬虫软件程序;一是负责不断更改爬虫软件程序中的IP地址,防止被检测到;一个使用不同的IP地址集和爬虫。程序向Kumike发送数据请求;一个负责破解Kumike客户端的加密算法;破解失败后,另一名员工聘请其他公司的技术人员帮助破解加密系统,使爬虫工作得以顺利实施。

这一系列数据操作取得了显著成效,帮助“车来”获取了大量实时久米克数据,每天可达3-4百万条。

花费大量人力、时间和经济成本获得的信息被同行窃取,直接挤压了自身的竞争优势和交易机会。久木怎么能和解?

2016 年,久米克一怒之下将这辆车告上法庭。这场争端花了两年时间才最终得到解决。今年5月,法院裁定车来应立即停止获取和使用久米克实时公交位置数据的不正当竞争行为,并赔偿其经济损失。

想必看到这里,大家最关心的问题就是五名程序员会不会被定罪?尽管在诉讼过程中,五名程序员的员工第二次使用网络爬虫获取公交车车辆的实时信息,只是因为他们履行了本职工作,并未用于谋取私利。但是,Kumike 后端服务器中存储的数据具有巨大的商业价值。未经其许可,任何人不得非法获取软件后台数据并将其用于商业行为——因此必须承担连带责任。

对此,中关村大数据联盟副秘书长陈新和先生表示,“数据爬虫的非法边界一直是互联网争议的热点,尤其是在大数据时代,随着越来越突出的内容数据的价值,爬虫侵权案件越来越多。” 身处其中的程序员很难置身于上级发出的“爬虫需求”之外,一不小心就有可能入局。

02 爬虫类犯罪认定仍不明朗,仍处于灰色地带

事实上,爬虫类犯罪一直是一个难以界定的灰色地带。

网络爬虫是一种自动获取网页内容的程序。通常,这并不违法。比如百度搜索,很多人用的,除了自己的百度知道、百度百科等,几乎都是爬虫采集down。作为一项技术,爬虫本身并不违法,因此在大多数情况下都可以放心使用。一般来说,常见的爬虫方法包括构造合理的HTTP请求头、设置cookie、降低访问频率、隐式输入字段值、使用代理等。

例如,大数据(ID:hzdashuju)、CSDN等平台此前分享了北京二手房数据、网易云音乐评论、马蜂窝旅游数据、大众点评、福利3D信息等应用数据爬取。但并不是所有数据都有“爬墙机会”,陈新和说,“能不能不爬,能不能越界爬,能不能用技术手段越过封锁……这些打擦边球的爬虫?很容易错过目标。” ——尤其是当网站明确声明爬行动物 采集 或禁止转载用于商业化,或者当 网站 声明机器人协议时。

Robots协议又称爬虫协议、机器人协议,全称是“Robots Exclusion Protocol”。网站通过Robots协议告诉爬虫哪些页面可以爬取,哪些页面禁止爬取。

机器人协议是搜索引擎行业公认的商业道德,应予以遵守。

尽管如此,仍有无数“勇者”尝试过自己的风险,包括我们熟悉的百度、360搜索、大众点评、今日头条等:

事实上,可以预见的是,由于目前监管法律的不完善,仍有不少鱼漏网之鱼。但随着数据价值的不断挖掘,未来爬虫侵权案件只会越来越多。

03 第三方网站应该如何应对日益猖獗的爬虫行为?

面对日益猖獗的爬虫行为,作为网站党的你应该如何应对?

既然有“爬虫”,自然就有“反爬虫”。网站常用的反爬虫技术可以分为四类:通过User-Agent控制访问、通过IP限制反爬虫、通过JS脚本阻止爬虫、通过robots.txt限制爬虫。

下面我们通过几个热门网站来分析常见的反爬机制:

1. 豆瓣

很多新爬虫都会爬豆瓣练手,但豆瓣也不是完全豁达。其反爬机制如下:

可以看出,豆瓣对于新爬虫来说是一个非常体贴的网站。只要爬虫在代码中登录账号,减少并发数,然后随机延迟等待一段时间,爬虫程序就不会被阻塞。

2. 拉钩网

拉狗网原来的反爬机制没有现在那么严格,但是随着关注者的增加,网站管理员增加了一些保护服务器的手段。网站的反爬机制如下:

对于这样的爬虫机制,爬虫只能使用IP代理池进行突围。

3. 汽车之家

汽车之家论坛的反爬机制比较先进。它采用前端页面自定义字体的方式,实现反爬的技术手段。具体来说,CSS3中的自定义字体模块用于将自定义Web字体嵌入到指定的网页中。这导致在抓取论坛帖子的口碑时,返回的文本中每隔几个单词就会出现一个乱码。

每次访问论坛页面,字体不变,但字符编码发生变化。因此,爬虫需要根据每次访问动态解析字体文件。具体来说,需要先访问爬取的页面,获取字体文件的动态访问地址,下载字体,读取JS渲染的文本内容,将自定义的字体编码替换为实际的文本编码,再将网页恢复为页面上看到的内容。.

……

然而,反爬虫并不是万能的。“以保护用户数据为名,全面禁止数据垄断爬取的策略,也将受到数据经济时代新反垄断法的挑战。” 陈新和说。

04 程序员如何在数据爬取中“不碍事”?

然而,技术是无罪的,那么程序员应该有罪吗?按照上级的指示写了几行代码,你就莫名被关起来了?可怕的是,他不仅傻眼,而且还无处申诉。

在知乎上,关于爬虫犯罪的问题也不少。在“爬行动物合法还是非法?”的问题下 ()、知乎user@pen核心设计师表示,爬虫开发者的道德自给和经营者的良知是避免触碰法律底线的根本所在:

我们周围的网络已经密密麻麻地布满了各种网络爬虫。作为爬虫开发者,如何避免在使用爬虫时陷入困境的厄运?

严格遵守网站设定的Robots协议;在规避反爬措施的同时,需要优化自己的代码,避免干扰被访问的网站的正常运行;在设置抓取策略时,要注意编码抓取 抓取可能构成视频、音乐等作品的数据,或者针对某些特定的网站批量抓取用户生成的内容;在使用和传播捕获的信息时,应对捕获的内容进行审核,如发现属于用户的个人信息、隐私或他人商业秘密,应及时停止并删除。

因此,面对来自上级的危险爬虫请求,程序员应该采取良好的措施。

对于涉及法律风险的数据爬取需求,程序员最好在采集之前和上级进行一次深入的交谈,并给上级简单介绍一下所涉及的法律风险。如果对方仍然坚持采集,建议提前与公司签订免责协议,避免风险出现时被拉入水中。

参考:

本文经授权转自公众号CSDN(ID:CSDNnews),作者郭锐

问:科技有罪还是无罪?

抓取网页数据违法吗(Robots协议(也称为爬虫协议、机器人协议等)的全称)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-01-15 14:04

Robots Protocol(也称Crawler Protocol、Robot Protocol等)的全称是“Robots Exclusion Protocol”。网站机器人协议告诉爬虫哪些页面可以爬取,哪些页面不能爬取。

robots.txt 文件是一个文本文件,可以使用任何常见的文本编辑器(例如 Windows 系统附带的记事本)创建和编辑。robots.txt 是协议,而不是命令。robots.txt 是搜索引擎在访问 网站 时查看的第一个文件。robots.txt 文件告诉蜘蛛可以查看服务器上的哪些文件。

如何检查采集的内容是否有rebots协议?

其实方法很简单。如果您想查看它,只需在 IE 上输入您的 URL/robots.txt。如果要查看和分析机器人,有专业的相关工具和站长工具!

爬虫作为一种计算机技术,决定了它的中立性,所以爬虫本身并没有被法律禁止,但是利用爬虫技术获取数据是违法的,甚至是犯罪的。

比如像谷歌这样的搜索引擎爬虫每隔几天就会扫描整个网页给大家查看,大部分被扫描的网站都非常开心。这被定义为“善意的爬行动物”。但是像抢票软件这样的爬虫却迫不及待地每秒拍打12306几万次,但铁先生却觉得不是很开心。这种爬虫被定义为“恶意爬虫”。

爬行动物带来的风险主要体现在以下三个方面:

解释爬虫的定义:网络爬虫,也称为蜘蛛,是一种用于自动浏览万维网的网络机器人。

网络爬虫爬取的数据有以下规则:

常见误解:认为爬虫是用来抓取个人信息的,与基本信用数据有关。

一般来说,技术是无辜的,但如果你使用技术来爬取他人的隐私和业务数据,那么你就是在藐视法律

本文首发于python黑洞网络,csdn同步更新 查看全部

抓取网页数据违法吗(Robots协议(也称为爬虫协议、机器人协议等)的全称)

Robots Protocol(也称Crawler Protocol、Robot Protocol等)的全称是“Robots Exclusion Protocol”。网站机器人协议告诉爬虫哪些页面可以爬取,哪些页面不能爬取。

robots.txt 文件是一个文本文件,可以使用任何常见的文本编辑器(例如 Windows 系统附带的记事本)创建和编辑。robots.txt 是协议,而不是命令。robots.txt 是搜索引擎在访问 网站 时查看的第一个文件。robots.txt 文件告诉蜘蛛可以查看服务器上的哪些文件。

如何检查采集的内容是否有rebots协议?

其实方法很简单。如果您想查看它,只需在 IE 上输入您的 URL/robots.txt。如果要查看和分析机器人,有专业的相关工具和站长工具!

爬虫作为一种计算机技术,决定了它的中立性,所以爬虫本身并没有被法律禁止,但是利用爬虫技术获取数据是违法的,甚至是犯罪的。

比如像谷歌这样的搜索引擎爬虫每隔几天就会扫描整个网页给大家查看,大部分被扫描的网站都非常开心。这被定义为“善意的爬行动物”。但是像抢票软件这样的爬虫却迫不及待地每秒拍打12306几万次,但铁先生却觉得不是很开心。这种爬虫被定义为“恶意爬虫”。

爬行动物带来的风险主要体现在以下三个方面:

解释爬虫的定义:网络爬虫,也称为蜘蛛,是一种用于自动浏览万维网的网络机器人。

网络爬虫爬取的数据有以下规则:

常见误解:认为爬虫是用来抓取个人信息的,与基本信用数据有关。

一般来说,技术是无辜的,但如果你使用技术来爬取他人的隐私和业务数据,那么你就是在藐视法律

本文首发于python黑洞网络,csdn同步更新

抓取网页数据违法吗(第一章:反爬基础简介:requests模块基础requests)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-01-15 00:13

第 1 章:反爬虫基础知识介绍第 2 章:请求模块的基础知识

01.请求First Blood.py

02.请求网页采集器.py

03.请求实战百度翻译.py

第一章:防爬基础介绍

前戏:

1.夜深人静,想看几张让你睡不着觉却又苦于资源匮乏的图片……

2.要不要在假期旺季快速抢购优采云门票……

3.网购时,您是否想快速准确地定位到口碑和质量最好的产品……

什么是爬行动物:

- 通过编写程序,模拟浏览器上网的过程,然后让它上网抓取数据。

爬行动物的价值:

- 实际应用

- 就业

爬行动物是合法的还是非法的?

爬行动物带来的风险可以体现在以下两个方面:

- 爬虫干扰了访问的网站的正常运行

- 爬虫爬取受法律保护的特定类型的数据或信息

在使用写字爬虫的过程中如何避免进入游戏的厄运?

- 始终优化自己的程序,避免干扰访问网站的正常运行

- 在使用和传播爬取数据时,对爬取的内容进行审核,如果发现涉及用户隐私

商业机密等敏感内容需及时停止爬取或传播

爬虫在使用场景中的分类

- 通用爬虫:

抓取系统的重要组成部分。它抓取一整页数据。

- 专注于爬虫:

它基于通用爬虫。爬取是页面的特定部分内容。

- 增量爬虫:

检测 网站 中的数据更新。只会捕获 网站 中最新更新的数据。

爬行动物的矛和盾

反爬机制

门户网站可以通过制定相应的策略或技术手段来防止爬虫程序爬取网站数据。

反反爬策略

爬虫程序可以通过制定相关策略或技术手段破解门户网站中的反爬机制,从而获取门户网站中的相关数据。

robots.txt 协议:

君子协定。指定网站中哪些数据可以被爬虫爬取,哪些数据不能被爬取。 查看全部

抓取网页数据违法吗(第一章:反爬基础简介:requests模块基础requests)

第 1 章:反爬虫基础知识介绍第 2 章:请求模块的基础知识

01.请求First Blood.py

02.请求网页采集器.py

03.请求实战百度翻译.py

第一章:防爬基础介绍

前戏:

1.夜深人静,想看几张让你睡不着觉却又苦于资源匮乏的图片……

2.要不要在假期旺季快速抢购优采云门票……

3.网购时,您是否想快速准确地定位到口碑和质量最好的产品……

什么是爬行动物:

- 通过编写程序,模拟浏览器上网的过程,然后让它上网抓取数据。

爬行动物的价值:

- 实际应用

- 就业

爬行动物是合法的还是非法的?

爬行动物带来的风险可以体现在以下两个方面:

- 爬虫干扰了访问的网站的正常运行

- 爬虫爬取受法律保护的特定类型的数据或信息

在使用写字爬虫的过程中如何避免进入游戏的厄运?

- 始终优化自己的程序,避免干扰访问网站的正常运行

- 在使用和传播爬取数据时,对爬取的内容进行审核,如果发现涉及用户隐私

商业机密等敏感内容需及时停止爬取或传播

爬虫在使用场景中的分类

- 通用爬虫:

抓取系统的重要组成部分。它抓取一整页数据。

- 专注于爬虫:

它基于通用爬虫。爬取是页面的特定部分内容。

- 增量爬虫:

检测 网站 中的数据更新。只会捕获 网站 中最新更新的数据。

爬行动物的矛和盾

反爬机制

门户网站可以通过制定相应的策略或技术手段来防止爬虫程序爬取网站数据。

反反爬策略

爬虫程序可以通过制定相关策略或技术手段破解门户网站中的反爬机制,从而获取门户网站中的相关数据。

robots.txt 协议:

君子协定。指定网站中哪些数据可以被爬虫爬取,哪些数据不能被爬取。

抓取网页数据违法吗( 讲讲如何抓取网页表格里的数据(1)_1. )

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2022-02-05 22:22

讲讲如何抓取网页表格里的数据(1)_1.

)

今天我们将讨论如何在 Web 表单中捕获数据。首先我们来分析一下网页中的经典表格是如何组成的。

经典的表格都是关于这些知识点的,没了。让我们编写一个简单的表单 Web Scraper 爬虫。

1.创建站点地图

我们今天的练习 网站 是

%C9%CF%BA%A3&txt道达=%B1%B1%BE%A9

爬虫的内容是爬取上海到北京的所有火车时刻表。

我们首先创建一个收录整个表格的容器,并将Type选择为Table,表示我们要抓取表格。

具体参数如上图所示,因为比较简单,就不多说了。

在此面板下向下滚动,您会发现一个不同的面板。如果你看一下,你会发现这些数据实际上是表数据类型的分类。在这种情况下,他列出了火车、出发站和行驶时间的类别。

在表格列类别中,默认勾选每行内容旁边的选择按钮,这意味着默认捕获这些列的内容。如果您不想爬取某种类型的内容,只需去掉相应的复选框即可。

当你点击保存选择器按钮的时候,你会发现Result键的一些选项报错,说invalid format format无效:

解决这个错误非常简单。一般来说,Result 键名的长度是不够的。您可以添加空格和标点符号。如果仍然出现错误,请尝试更改为英文名称:

解决错误并保存成功后,我们就可以按照Web Scraper的爬取例程抓取数据了。

2.我为什么不建议你使用 Web Scraper 的表格选择器?

如果按照刚才的教程,感觉会很流畅,但是看数据的时候,就傻眼了。

刚开始爬的时候,我们先用Data preview预览数据,发现数据很完美:

抓取数据后,在浏览器的预览面板中预览,会发现trains一栏的数据为null,表示没有抓取到相关内容:

我们下载捕获的CSV文件并在预览器中打开后,我们会发现出现了列车号的数据,但是出发站的数据又为空了!

这不是傻子!

我已经研究这个问题很长时间了。应该是Web Scraper对中文关键词索引的支持不是很友好,所以会抛出一些奇怪的bug,所以不建议大家使用它的Table功能。

如果真的要抓取表数据,可以使用前面的方案,先创建一个Element类型的容器,然后在容器中手动创建一个子选择器,这样就可以避免这个问题了。

以上只是一个原因,另一个原因是,在现代 网站 中,很少有人再使用 HTML 原创表格了。

HTML 为表格提供了基本的标签,例如

, , 等标签,提供默认样式。优点是互联网刚开发的时候,可以提供开箱即用的形式;缺点是样式过于简单,不易定制。后来很多网站用其他标签来模拟表格,就像PPT用各种大小的块组合成一个表格,很容易自定义:

正因如此,当你使用Table Selector匹配一个表格的时候,可能会匹配不上,因为从Web Scraper的角度来看,你看到的表格是高仿的,根本不是原装的,自然不是。认可。

3.总结

我们不建议直接使用 Web Scraper 的 Table Selector,因为它对中文支持不是很友好,也不太适合现代网页。如果有抢表的需求,可以使用之前创建父子选择器的方法来做。

在之前的文章文章中,我们介绍了Web Scraper对各种翻页的解决方案,比如修改网页链接加载数据、点击“更多按钮”加载数据、下拉自动加载数据等。今天我们讲一种比较常见的翻页方式——pager。

我本来想解释什么是寻呼机,但是我发现浏览一堆定义很麻烦。大家上网已经不是第一年了,看图就知道了。我找到了一个功能齐全的例子,支持数字页码调整,上一页到下一页和指定页数跳转。

今天我们将学习 Web Scraper 如何处理这种类型的翻页。

其实在本教程的第一个例子中,我们就抢到了豆瓣电影TOP排行榜。这个豆瓣电影列表使用寻呼机来划分数据:

但是当时我们是在找网页链接定期爬取,并没有使用pager来爬取。因为当一个网页的链接有规律的变化时,控制链接参数的爬取成本是最低的;如果可以翻页,但是链接的变化不规律,就得去pager了一会儿。

说这些理论有点无聊,我们举个不规则翻页链接的例子。

8月2日是蔡徐坤的生日。为了庆祝,微博上的粉丝给了坤坤300W的转发。微博的转发恰好是被寻呼机分割的,所以我们来分析一下微博的转发。信息页面,了解如何使用 Web Scraper 抓取此类数据。

这条微博的直接链接是:

看了这么多他的视频,为了表达我们的感激之情,我们可以点进去给坤坤加个阅读量。

首先我们看第1页转发的链接,长这样:

第二页是这样的,我注意到有一个额外的#_rnd36 参数:

#_rnd36

第三页参数为#_rnd39

#_rnd39

第 4 页参数是#_rnd76:

#_rnd76

多看几个链接,会发现这个转发页面的URL没有规则,只能通过pager加载数据。让我们开始我们的实践教学课程。

1.创建站点地图

我们首先创建一个SiteMap,这次命名为cxk,起始链接为

2.为容器创建一个选择器

因为我们要点击pager,所以我们选择外层容器的类型为Element Click。具体参数说明见下图。我们之前在《简单数据分析08》中详细讲解过,这里就不多说了。

容器的预览如下图所示:

寻呼机选择过程如下图所示:

3.创建子选择器

这些子选择器比较简单,类型都是文本选择器。我们选择了三种类型的内容:评论用户名、评论内容和评论时间。

4.捕获数据

可以根据Sitemap cxk -> Scrape 的操作路径抓取数据。

5.一些问题

如果你看了我上面的教程,马上爬数据,你可能遇到的第一个问题就是,300w的数据,我需要一直爬下去吗?

听起来很不现实。毕竟Web Scraper针对的数据量比较少,上万的数据算太多了。不管数据有多大,都要考虑爬取时间是否过长,数据如何存储,如何处理。网站的反爬系统(比如突然弹出一个验证码,这个Web Scraper无能为力)。

考虑到这个问题,如果你看过上一篇关于自动控制抓取次数的教程,你可能会想到使用 :nth-of-type(-n+N) 来控制 N 条数据的抓取。如果你尝试一下,你会发现这个方法根本行不通。

失败的原因其实涉及到一点网页知识。如果您有兴趣,可以阅读下面的说明。不感兴趣的可以直接看最后的结论。

就像我之前介绍的更多加载网页和下拉加载网页一样,它们新加载的数据是附加到当前页面的。你不断向下滚动,数据不断加载,网页的滚动条会越来越短。表示所有数据都在同一页面上。

当我们使用:nth-of-type(-n+N) 来控制加载次数的时候,其实就相当于在这个网页上设置了一个计数器。当数据已经累积到我们想要的数量时,它就会停止爬取。

但是对于使用分页器的网页,每翻一页就相当于刷新当前网页,这样每次都会设置一个计数器。

比如你要抓1000条数据,但是第一页只有20条数据,抓到最后一条,还有980条数据。对于一条数据,还有980,一翻页计数器就清零,又变成1000了……所以这种控制数的方法是无效的。

所以结论是,如果一个pager类的网页想要提前结束爬取,唯一的办法就是断网。当然,如果您有更好的解决方案,可以在评论中回复我,我们可以互相讨论。

6.总结

Pager 是一种非常常见的网页分页方法。我们可以通过 Web Scraper 中的 Element click 处理此类网页,并通过断开网络来结束爬取。

●简单的数据分析(六):Web Scraper翻页-抓取“滚动加载”类型的网页

●简单数据分析(二):Web Scraper尝鲜,抢豆瓣高分电影

●简单的数据分析(一):起源,了解Web Scraper和浏览器技巧

·结尾·

图克社区

采集精彩的免费实用教程

查看全部

抓取网页数据违法吗(

讲讲如何抓取网页表格里的数据(1)_1.

)

今天我们将讨论如何在 Web 表单中捕获数据。首先我们来分析一下网页中的经典表格是如何组成的。

经典的表格都是关于这些知识点的,没了。让我们编写一个简单的表单 Web Scraper 爬虫。

1.创建站点地图

我们今天的练习 网站 是

%C9%CF%BA%A3&txt道达=%B1%B1%BE%A9

爬虫的内容是爬取上海到北京的所有火车时刻表。

我们首先创建一个收录整个表格的容器,并将Type选择为Table,表示我们要抓取表格。

具体参数如上图所示,因为比较简单,就不多说了。

在此面板下向下滚动,您会发现一个不同的面板。如果你看一下,你会发现这些数据实际上是表数据类型的分类。在这种情况下,他列出了火车、出发站和行驶时间的类别。

在表格列类别中,默认勾选每行内容旁边的选择按钮,这意味着默认捕获这些列的内容。如果您不想爬取某种类型的内容,只需去掉相应的复选框即可。

当你点击保存选择器按钮的时候,你会发现Result键的一些选项报错,说invalid format format无效:

解决这个错误非常简单。一般来说,Result 键名的长度是不够的。您可以添加空格和标点符号。如果仍然出现错误,请尝试更改为英文名称:

解决错误并保存成功后,我们就可以按照Web Scraper的爬取例程抓取数据了。

2.我为什么不建议你使用 Web Scraper 的表格选择器?

如果按照刚才的教程,感觉会很流畅,但是看数据的时候,就傻眼了。

刚开始爬的时候,我们先用Data preview预览数据,发现数据很完美:

抓取数据后,在浏览器的预览面板中预览,会发现trains一栏的数据为null,表示没有抓取到相关内容:

我们下载捕获的CSV文件并在预览器中打开后,我们会发现出现了列车号的数据,但是出发站的数据又为空了!

这不是傻子!

我已经研究这个问题很长时间了。应该是Web Scraper对中文关键词索引的支持不是很友好,所以会抛出一些奇怪的bug,所以不建议大家使用它的Table功能。

如果真的要抓取表数据,可以使用前面的方案,先创建一个Element类型的容器,然后在容器中手动创建一个子选择器,这样就可以避免这个问题了。

以上只是一个原因,另一个原因是,在现代 网站 中,很少有人再使用 HTML 原创表格了。

HTML 为表格提供了基本的标签,例如

, , 等标签,提供默认样式。优点是互联网刚开发的时候,可以提供开箱即用的形式;缺点是样式过于简单,不易定制。后来很多网站用其他标签来模拟表格,就像PPT用各种大小的块组合成一个表格,很容易自定义:

正因如此,当你使用Table Selector匹配一个表格的时候,可能会匹配不上,因为从Web Scraper的角度来看,你看到的表格是高仿的,根本不是原装的,自然不是。认可。

3.总结

我们不建议直接使用 Web Scraper 的 Table Selector,因为它对中文支持不是很友好,也不太适合现代网页。如果有抢表的需求,可以使用之前创建父子选择器的方法来做。

在之前的文章文章中,我们介绍了Web Scraper对各种翻页的解决方案,比如修改网页链接加载数据、点击“更多按钮”加载数据、下拉自动加载数据等。今天我们讲一种比较常见的翻页方式——pager。

我本来想解释什么是寻呼机,但是我发现浏览一堆定义很麻烦。大家上网已经不是第一年了,看图就知道了。我找到了一个功能齐全的例子,支持数字页码调整,上一页到下一页和指定页数跳转。

今天我们将学习 Web Scraper 如何处理这种类型的翻页。

其实在本教程的第一个例子中,我们就抢到了豆瓣电影TOP排行榜。这个豆瓣电影列表使用寻呼机来划分数据:

但是当时我们是在找网页链接定期爬取,并没有使用pager来爬取。因为当一个网页的链接有规律的变化时,控制链接参数的爬取成本是最低的;如果可以翻页,但是链接的变化不规律,就得去pager了一会儿。

说这些理论有点无聊,我们举个不规则翻页链接的例子。

8月2日是蔡徐坤的生日。为了庆祝,微博上的粉丝给了坤坤300W的转发。微博的转发恰好是被寻呼机分割的,所以我们来分析一下微博的转发。信息页面,了解如何使用 Web Scraper 抓取此类数据。

这条微博的直接链接是:

看了这么多他的视频,为了表达我们的感激之情,我们可以点进去给坤坤加个阅读量。

首先我们看第1页转发的链接,长这样:

第二页是这样的,我注意到有一个额外的#_rnd36 参数:

#_rnd36

第三页参数为#_rnd39

#_rnd39

第 4 页参数是#_rnd76:

#_rnd76

多看几个链接,会发现这个转发页面的URL没有规则,只能通过pager加载数据。让我们开始我们的实践教学课程。

1.创建站点地图

我们首先创建一个SiteMap,这次命名为cxk,起始链接为

2.为容器创建一个选择器

因为我们要点击pager,所以我们选择外层容器的类型为Element Click。具体参数说明见下图。我们之前在《简单数据分析08》中详细讲解过,这里就不多说了。

容器的预览如下图所示:

寻呼机选择过程如下图所示:

3.创建子选择器

这些子选择器比较简单,类型都是文本选择器。我们选择了三种类型的内容:评论用户名、评论内容和评论时间。

4.捕获数据

可以根据Sitemap cxk -> Scrape 的操作路径抓取数据。

5.一些问题

如果你看了我上面的教程,马上爬数据,你可能遇到的第一个问题就是,300w的数据,我需要一直爬下去吗?

听起来很不现实。毕竟Web Scraper针对的数据量比较少,上万的数据算太多了。不管数据有多大,都要考虑爬取时间是否过长,数据如何存储,如何处理。网站的反爬系统(比如突然弹出一个验证码,这个Web Scraper无能为力)。

考虑到这个问题,如果你看过上一篇关于自动控制抓取次数的教程,你可能会想到使用 :nth-of-type(-n+N) 来控制 N 条数据的抓取。如果你尝试一下,你会发现这个方法根本行不通。

失败的原因其实涉及到一点网页知识。如果您有兴趣,可以阅读下面的说明。不感兴趣的可以直接看最后的结论。

就像我之前介绍的更多加载网页和下拉加载网页一样,它们新加载的数据是附加到当前页面的。你不断向下滚动,数据不断加载,网页的滚动条会越来越短。表示所有数据都在同一页面上。

当我们使用:nth-of-type(-n+N) 来控制加载次数的时候,其实就相当于在这个网页上设置了一个计数器。当数据已经累积到我们想要的数量时,它就会停止爬取。

但是对于使用分页器的网页,每翻一页就相当于刷新当前网页,这样每次都会设置一个计数器。