抓取动态网页

抓取动态网页(ajax横行的年代,我们的网页是残缺的吗? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-09-29 15:28

)

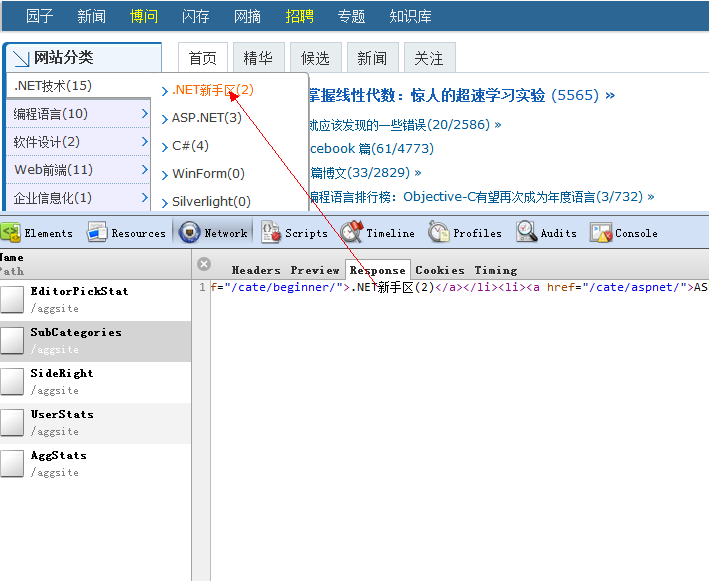

在Ajax时代,许多网页的内容都是动态加载的,我们的小爬虫只抓取web服务器返回给我们的HTML

跳过了JS加载部分,即爬虫抓取的网页不完整、不完整。你可以看到下面博客花园的首页

从主页加载中,我们可以看到页面呈现后,将有五个Ajax异步请求。默认情况下,爬虫程序无法抓取Ajax生成的内容

此时,如果要获取这些动态页面,必须调用浏览器的内核引擎来下载这些动态页面。目前,内核引擎有三个支柱

三叉戟:即内核。WebBrowser基于此内核,但其可加载性较差

壁虎:FF的内核比Trident有更好的性能

WebKit:Safari和chrome的内核性能,你知道,在真实场景中仍然基于它

好吧,为了简单和方便,让我们使用WebBrowser来玩。使用WebBrowser时,我们应注意以下几点:

第一:因为WebBrowser是system.windows.forms中的WinForm控件,所以我们需要设置StatThread标志

第二:WinForm是事件驱动的,控制台不响应事件。所有事件都在windows的消息队列中等待执行。为了不让程序假装死亡

我们需要调用Doevents方法来转移控制,并让操作系统执行其他事件

第三:我们需要使用domdocument而不是documenttext来查看WebBrowser中的内容

通常有两种方法来判断是否加载了动态网页:

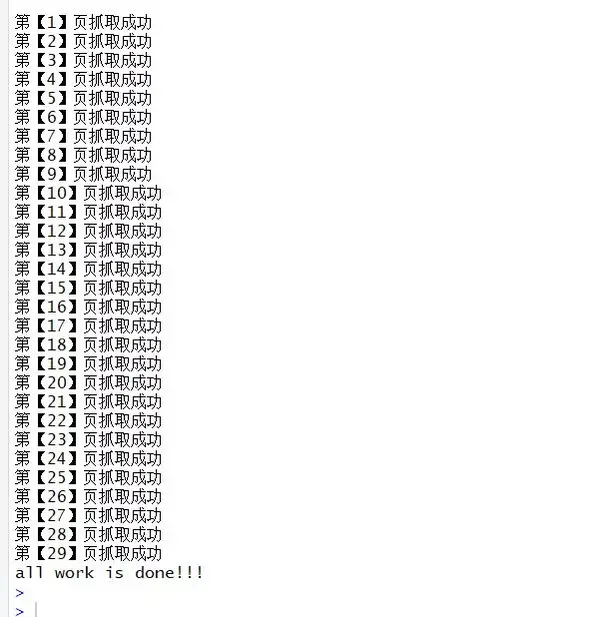

① : 在这里设置一个最大值,因为每次异步加载JS时,都会触发导航和documentcompleted事件,所以我们需要

只需将计数值记录在

1 using System; 2 using System.Collections.Generic; 3 using System.Linq; 4 using System.Text; 5 using System.Windows.Forms; 6 using System.Threading; 7 using System.IO; 8 9 namespace ConsoleApplication210 {11 public class Program12 {13 static int hitCount = 0;14 15 [STAThread]16 static void Main(string[] args)17 {18 string url = "http://www.cnblogs.com";19 20 WebBrowser browser = new WebBrowser();21 22 browser.ScriptErrorsSuppressed = true;23 24 browser.Navigating += (sender, e) =>25 {26 hitCount++;27 };28 29 browser.DocumentCompleted += (sender, e) =>30 {31 hitCount++;32 };33 34 browser.Navigate(url);35 36 while (browser.ReadyState != WebBrowserReadyState.Complete)37 {38 Application.DoEvents();39 }40 41 while (hitCount 35 {36 //加载完毕37 isComplete = true;38 39 timer.Stop();40 });41 42 timer.Interval = 1000 * 5;43 44 timer.Start();45 46 //继续等待 5s,等待js加载完47 while (!isComplete)48 Application.DoEvents();49 50 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument;51 52 string gethtml = htmldocument.documentElement.outerHTML;53 54 //写入文件55 using (StreamWriter sw = new StreamWriter(Environment.CurrentDirectory + "//1.html"))56 {57 sw.WriteLine(gethtml);58 }59 60 Console.WriteLine("html 文件 已经生成!");61 62 Console.Read();63 }64 }65 }

当然,效果是一样的,所以我们不会截图。通过以上两种编写方法,我们的WebBrowser被放置在主线程中。让我们看看如何把它放在工作线程上

非常简单,只需将工作线程设置为sta模式

<p> 1 using System; 2 using System.Collections.Generic; 3 using System.Linq; 4 using System.Text; 5 using System.Windows.Forms; 6 using System.Threading; 7 8 namespace ConsoleApplication2 9 {10 public class Program11 {12 static int hitCount = 0;13 14 //[STAThread]15 static void Main(string[] args)16 {17 Thread thread = new Thread(new ThreadStart(() =>18 {19 Init();20 System.Windows.Forms.Application.Run();21 }));22 23 //将该工作线程设定为STA模式24 thread.SetApartmentState(ApartmentState.STA);25 26 thread.Start();27 28 Console.Read();29 }30 31 static void Init()32 {33 string url = "http://www.cnblogs.com";34 35 WebBrowser browser = new WebBrowser();36 37 browser.ScriptErrorsSuppressed = true;38 39 browser.DocumentCompleted += new WebBrowserDocumentCompletedEventHandler(browser_DocumentCompleted);40 41 browser.Navigating += new WebBrowserNavigatingEventHandler(browser_Navigating);42 43 browser.Navigate(url);44 45 while (browser.ReadyState != WebBrowserReadyState.Complete)46 {47 Application.DoEvents();48 }49 50 while (hitCount 查看全部

抓取动态网页(ajax横行的年代,我们的网页是残缺的吗?

)

在Ajax时代,许多网页的内容都是动态加载的,我们的小爬虫只抓取web服务器返回给我们的HTML

跳过了JS加载部分,即爬虫抓取的网页不完整、不完整。你可以看到下面博客花园的首页

从主页加载中,我们可以看到页面呈现后,将有五个Ajax异步请求。默认情况下,爬虫程序无法抓取Ajax生成的内容

此时,如果要获取这些动态页面,必须调用浏览器的内核引擎来下载这些动态页面。目前,内核引擎有三个支柱

三叉戟:即内核。WebBrowser基于此内核,但其可加载性较差

壁虎:FF的内核比Trident有更好的性能

WebKit:Safari和chrome的内核性能,你知道,在真实场景中仍然基于它

好吧,为了简单和方便,让我们使用WebBrowser来玩。使用WebBrowser时,我们应注意以下几点:

第一:因为WebBrowser是system.windows.forms中的WinForm控件,所以我们需要设置StatThread标志

第二:WinForm是事件驱动的,控制台不响应事件。所有事件都在windows的消息队列中等待执行。为了不让程序假装死亡

我们需要调用Doevents方法来转移控制,并让操作系统执行其他事件

第三:我们需要使用domdocument而不是documenttext来查看WebBrowser中的内容

通常有两种方法来判断是否加载了动态网页:

① : 在这里设置一个最大值,因为每次异步加载JS时,都会触发导航和documentcompleted事件,所以我们需要

只需将计数值记录在

1 using System; 2 using System.Collections.Generic; 3 using System.Linq; 4 using System.Text; 5 using System.Windows.Forms; 6 using System.Threading; 7 using System.IO; 8 9 namespace ConsoleApplication210 {11 public class Program12 {13 static int hitCount = 0;14 15 [STAThread]16 static void Main(string[] args)17 {18 string url = "http://www.cnblogs.com";19 20 WebBrowser browser = new WebBrowser();21 22 browser.ScriptErrorsSuppressed = true;23 24 browser.Navigating += (sender, e) =>25 {26 hitCount++;27 };28 29 browser.DocumentCompleted += (sender, e) =>30 {31 hitCount++;32 };33 34 browser.Navigate(url);35 36 while (browser.ReadyState != WebBrowserReadyState.Complete)37 {38 Application.DoEvents();39 }40 41 while (hitCount 35 {36 //加载完毕37 isComplete = true;38 39 timer.Stop();40 });41 42 timer.Interval = 1000 * 5;43 44 timer.Start();45 46 //继续等待 5s,等待js加载完47 while (!isComplete)48 Application.DoEvents();49 50 var htmldocument = (mshtml.HTMLDocument)browser.Document.DomDocument;51 52 string gethtml = htmldocument.documentElement.outerHTML;53 54 //写入文件55 using (StreamWriter sw = new StreamWriter(Environment.CurrentDirectory + "//1.html"))56 {57 sw.WriteLine(gethtml);58 }59 60 Console.WriteLine("html 文件 已经生成!");61 62 Console.Read();63 }64 }65 }

当然,效果是一样的,所以我们不会截图。通过以上两种编写方法,我们的WebBrowser被放置在主线程中。让我们看看如何把它放在工作线程上

非常简单,只需将工作线程设置为sta模式

<p> 1 using System; 2 using System.Collections.Generic; 3 using System.Linq; 4 using System.Text; 5 using System.Windows.Forms; 6 using System.Threading; 7 8 namespace ConsoleApplication2 9 {10 public class Program11 {12 static int hitCount = 0;13 14 //[STAThread]15 static void Main(string[] args)16 {17 Thread thread = new Thread(new ThreadStart(() =>18 {19 Init();20 System.Windows.Forms.Application.Run();21 }));22 23 //将该工作线程设定为STA模式24 thread.SetApartmentState(ApartmentState.STA);25 26 thread.Start();27 28 Console.Read();29 }30 31 static void Init()32 {33 string url = "http://www.cnblogs.com";34 35 WebBrowser browser = new WebBrowser();36 37 browser.ScriptErrorsSuppressed = true;38 39 browser.DocumentCompleted += new WebBrowserDocumentCompletedEventHandler(browser_DocumentCompleted);40 41 browser.Navigating += new WebBrowserNavigatingEventHandler(browser_Navigating);42 43 browser.Navigate(url);44 45 while (browser.ReadyState != WebBrowserReadyState.Complete)46 {47 Application.DoEvents();48 }49 50 while (hitCount

抓取动态网页(知乎如何把一个网页爬下来?搞flask吧!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-09-28 16:33

抓取动态网页可以用imgurl()方法,这是python很早之前的方法,通过网页中的cookie,从cookie里提取title,description,transitiontime等参数,解析出图片链接,就可以定制它的url了。很久以前我用imgurl()方法做图片采集,不是很稳定,还会出现丢图片的情况,后来我采用appium这个安卓和ios双平台的api,这就是用selenium+sdk吧,很方便,可以弄出很多网页的截图,appium在跨平台方面做的比python要好很多,它只做获取,不做解析,解析更费时间,python搞一大堆代码才解析出来。

安卓的appium挺好用的,而且selenium也能做python的整合,我自己写了个第三方的测试框架,据说selenium有接口,不知道能不能用,可以免费测试,如果大家需要,私信我,我放链接给大家,测试框架的链接:密码:kafz。

python的安卓获取图片之前有个比较简单的案例用python抓取qq音乐一段音乐的图片(小米账号是否登录是一张图)可以在线看,

爬虫目前做过的有:1.-spider/spider/三种方式:官方提供的api,

来看看我的网站吧

-bootstrap/img

下面有个概念总结,相对比较全面的。

知乎如何把一个网页爬下来?

搞flask吧 查看全部

抓取动态网页(知乎如何把一个网页爬下来?搞flask吧!)

抓取动态网页可以用imgurl()方法,这是python很早之前的方法,通过网页中的cookie,从cookie里提取title,description,transitiontime等参数,解析出图片链接,就可以定制它的url了。很久以前我用imgurl()方法做图片采集,不是很稳定,还会出现丢图片的情况,后来我采用appium这个安卓和ios双平台的api,这就是用selenium+sdk吧,很方便,可以弄出很多网页的截图,appium在跨平台方面做的比python要好很多,它只做获取,不做解析,解析更费时间,python搞一大堆代码才解析出来。

安卓的appium挺好用的,而且selenium也能做python的整合,我自己写了个第三方的测试框架,据说selenium有接口,不知道能不能用,可以免费测试,如果大家需要,私信我,我放链接给大家,测试框架的链接:密码:kafz。

python的安卓获取图片之前有个比较简单的案例用python抓取qq音乐一段音乐的图片(小米账号是否登录是一张图)可以在线看,

爬虫目前做过的有:1.-spider/spider/三种方式:官方提供的api,

来看看我的网站吧

-bootstrap/img

下面有个概念总结,相对比较全面的。

知乎如何把一个网页爬下来?

搞flask吧

抓取动态网页(代码也可以从我的开源项目HtmlExtractor中获取。。 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-09-28 07:27

)

代码也可以从我的开源项目htmlextractor获得

当我们捕获数据时,如果目标网站是以JS和逐页滚动的形式动态生成数据,我们应该如何捕获它

比如今天的头条新闻网站:

我们可以使用硒来做到这一点。尽管selenium是为web应用程序的自动测试而设计的,但它非常适合数据捕获。它可以轻松绕过反爬虫限制网站,因为selenium与真实用户一样直接在浏览器中运行

使用selenium,我们不仅可以使用JS动态生成的数据对网页进行抓取,还可以通过滚动页面对页面进行抓取

首先,我们使用Maven引入selenium依赖关系:

< dependency >

< groupId >org.seleniumhq.selenium

< artifactId >selenium-java

< version >2.47.1

接下来,您可以编写代码来抓取:

<p>import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import java.util.List;

import java.util.Random;

/**

* 如何抓取Js动态生成数据且以滚动页面方式分页的网页

* 以抓取今日头条为例说明:http://toutiao.com/

* Created by ysc on 10/13/15.

*/

public class Toutiao {

public static void main(String[] args) throws Exception{

//等待数据加载的时间

//为了防止服务器封锁,这里的时间要模拟人的行为,随机且不能太短

long waitLoadBaseTime = 3000 ;

int waitLoadRandomTime = 3000 ;

Random random = new Random(System.currentTimeMillis());

//火狐浏览器

WebDriver driver = new FirefoxDriver();

//要抓取的网页

driver.get( "http://toutiao.com/" );

//等待页面动态加载完毕

Thread.sleep(waitLoadBaseTime+random.nextInt(waitLoadRandomTime));

//要加载多少页数据

int pages= 5 ;

for ( int i= 0 ; i 查看全部

抓取动态网页(代码也可以从我的开源项目HtmlExtractor中获取。。

)

代码也可以从我的开源项目htmlextractor获得

当我们捕获数据时,如果目标网站是以JS和逐页滚动的形式动态生成数据,我们应该如何捕获它

比如今天的头条新闻网站:

我们可以使用硒来做到这一点。尽管selenium是为web应用程序的自动测试而设计的,但它非常适合数据捕获。它可以轻松绕过反爬虫限制网站,因为selenium与真实用户一样直接在浏览器中运行

使用selenium,我们不仅可以使用JS动态生成的数据对网页进行抓取,还可以通过滚动页面对页面进行抓取

首先,我们使用Maven引入selenium依赖关系:

< dependency >

< groupId >org.seleniumhq.selenium

< artifactId >selenium-java

< version >2.47.1

接下来,您可以编写代码来抓取:

<p>import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import java.util.List;

import java.util.Random;

/**

* 如何抓取Js动态生成数据且以滚动页面方式分页的网页

* 以抓取今日头条为例说明:http://toutiao.com/

* Created by ysc on 10/13/15.

*/

public class Toutiao {

public static void main(String[] args) throws Exception{

//等待数据加载的时间

//为了防止服务器封锁,这里的时间要模拟人的行为,随机且不能太短

long waitLoadBaseTime = 3000 ;

int waitLoadRandomTime = 3000 ;

Random random = new Random(System.currentTimeMillis());

//火狐浏览器

WebDriver driver = new FirefoxDriver();

//要抓取的网页

driver.get( "http://toutiao.com/" );

//等待页面动态加载完毕

Thread.sleep(waitLoadBaseTime+random.nextInt(waitLoadRandomTime));

//要加载多少页数据

int pages= 5 ;

for ( int i= 0 ; i

抓取动态网页(动态网站解析的动态网页爬取方法(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2021-09-28 07:26

)

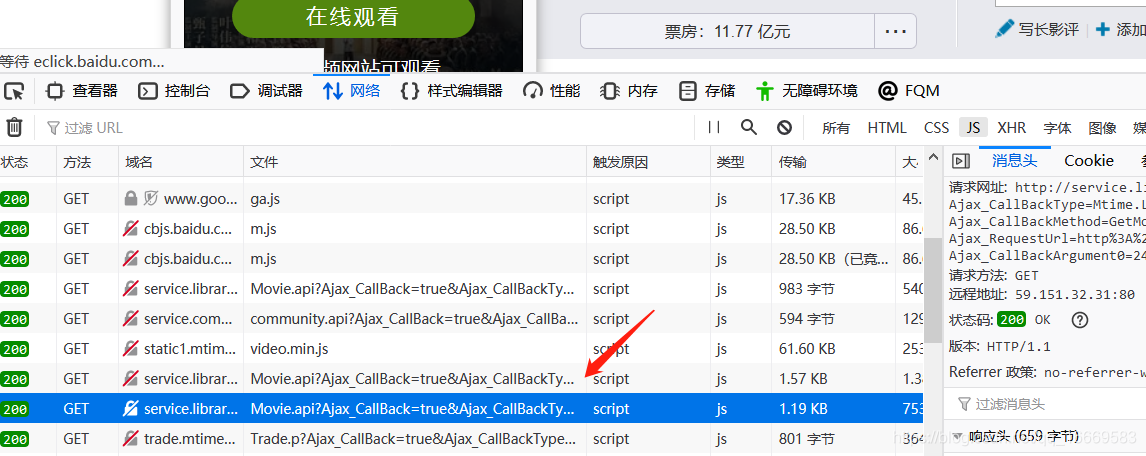

我刚才讲的是抓取静态网页。本篇博客介绍动态网站的爬取。动态网站的爬取比静态网页更难,涉及的主要技术是Ajax和动态Html。简单的网页访问无法获取完整的数据,需要分析数据加载过程。将通过具体的例子来介绍不同的动态网页爬取方法。本篇博客主要使用ajax直接获取数据。

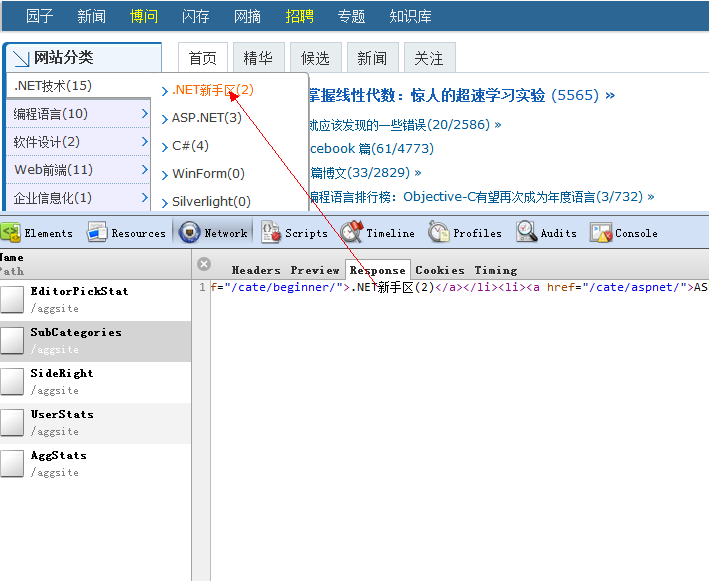

页面分析

本博客以MTime电影网为例,主要爬取电影收视率、票房等信息。首先使用火狐浏览器的控制台查看页面信息。

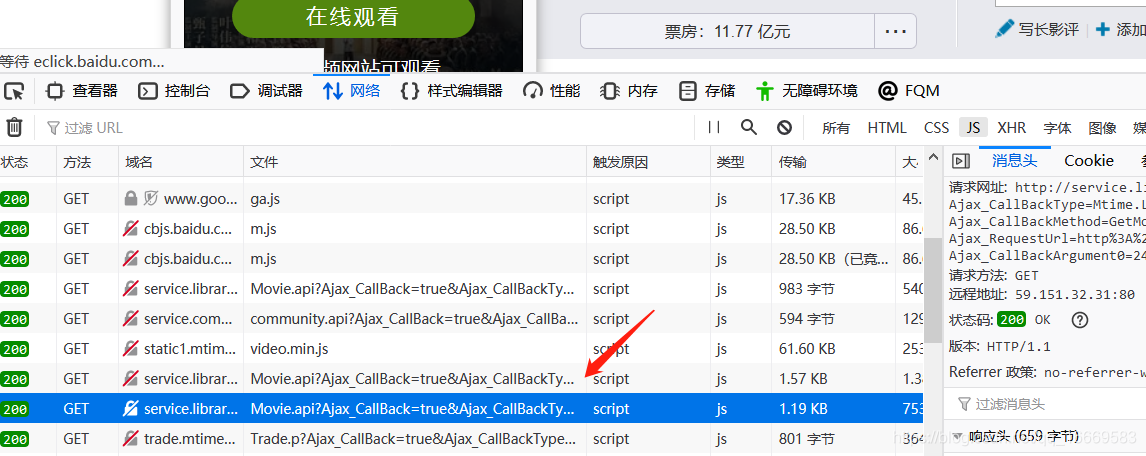

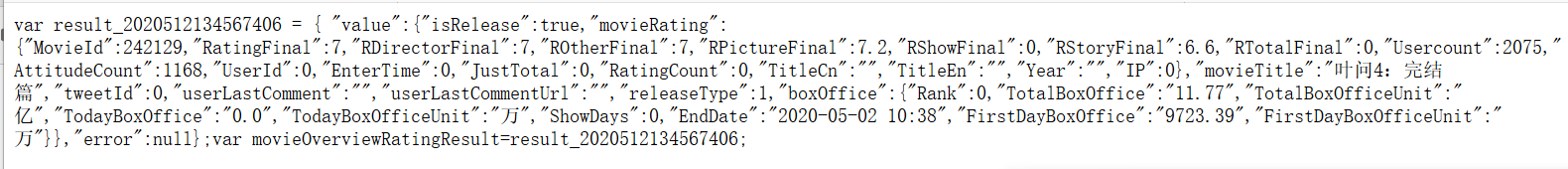

页面中的票房信息无法以 HTML 格式获取。是通过js动态加载得到的,然后搜索对应的js响应。就是从一堆js请求中查看一些收录ajax字段的请求。%3A%2F%%2F242129%2F&t=27406&Ajax_CallBackArgument0=242129

点击查看返回数据:

找到对应的链接并返回数据后,需要分析这个链接的构造方法,分析返回的数据。

(1)链接一共7个参数,我们首先要分析哪些参数没有变化,哪些参数在不同的电影中差异更大。通过对比两个不同的电影链接,可以发现其中4个是not 有动态变化的三个参数,分别是Ajax_RequestRrl、t和Ajax_CallBackArgument0,通过分析可以发现这三个参数分别代表当前页面url、当前请求时间、电影所代表的数量。

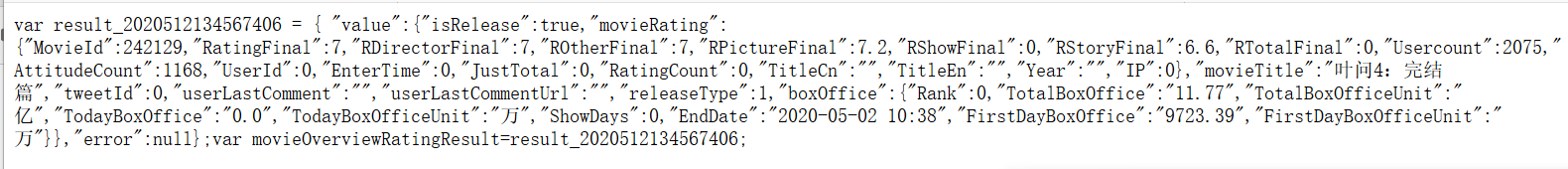

(2) 提取响应数据。响应内容主要分为三类,分别是正在上映的电影信息,即将上映的电影信息,最后一种是即将上映的电影信息发布很久了,详情见代码。

具体实现代码

本文代码基于博客实现。本博客只修改需要改动的部分。

网页分析

在HtmlParser类中定义一个parser_url方法,代码如下:

def parser_url(self, page_url, response):

pattern = re.compile(r'(http://movie.mtime.com/(\d+)/)')

urls = pattern.findall(response)

if urls != None:

return list(set(urls))

else:

return None

提取响应数据中的有效数据:

def parser_json(self, page_url, respone):

"""

解析响应

:param page_url:

:param respone:

:return:

"""

#将“=”和“;”之间的内容提取出来

pattern = re.compile(r'=(.*?);')

result = pattern.findall(respone)[0]

if result != None:

value = json.loads(result)

try:

isRelease = value.get('value').get('isRelease')

except Exception,e:

print(e)

return None

if isRelease:

if value.get('value').get('hotValue') == None:

return self._parser_release(page_url, value)

else:

self._parser_no_release(page_url, value, isRelease = 2)

else:

return self._parser_no_release(page_url, value)

def _parser_release(self, page_url, value):

"""

解析已上映的影片

:param page_url:

:param value:

:return:

"""

try:

isRelease = 1

movieRating = value.get('value').get('movieRating')

boxOffice = value.get('value').get('boxOffice')

movieTitle = value.get('value').get('movieTitle')

RPictureFinal = movieRating.get('RPictureFinal')

RStoryFinal = movieRating.get('RStoryFinal')

RDirectorFinal = movieRating.get('RDirectorFinal')

ROtherFinal = movieRating.get('ROtherFinal')

RatingFinal = movieRating.get('RatingFinal')

MovieId = movieRating.get('MovieId')

Usercount = movieRating.get('Usercount')

AttitudeCount = movieRating.get('AttitudeCount')

TotalBoxOffice = boxOffice.get('TotalBoxOffice')

TotalBoxOfficeUnit = boxOffice.get('TotalBoxOfficeUnit')

TodayBoxOffice = boxOffice.get('TodayBoxOffice')

TodayBoxOfficeUnit = boxOffice.get('TodayBoxOfficeUnit')

showDays = boxOffice.get('ShowDays')

try:

Rank = boxOffice.get('Rank')

except Exception,e:

Rank = 0

return (MovieId,movieTitle,RatingFinal,

ROtherFinal,RPictureFinal,RDirectorFinal,

RStoryFinal,Usercount,AttitudeCount,

TotalBoxOffice+TotalBoxOfficeUnit,

TodayBoxOffice+TodayBoxOfficeUnit,

Rank,showDays,isRelease)

except Exception,e:

print(e,page_url,value)

return None

def _parser_no_release(self,page_url,value,isRelease = 0):

try:

movieRating = value.get('value').get('movieRating')

movieTitle = value.get('value').get('movieTitle')

RPictureFinal = movieRating.get('RPictureFinal')

RStoryFinal = movieRating.get('RStoryFinal')

RDirectorFinal = movieRating.get('RDirectorFinal')

ROtherFinal = movieRating.get('ROtherFinal')

RatingFinal = movieRating.get('RatingFinal')

MovieId = movieRating.get('MovieId')

Usercount = movieRating.get('Usercount')

AttitudeCount = movieRating.get('AttitudeCount')

try:

Rank = value.get('value').get('hotValue').get('Ranking')

except Exception,e:

Rank = 0

return (MovieId,movieTitle,RatingFinal,

ROtherFinal,RPictureFinal,RDirectorFinal,

RStoryFinal,Usercount,AttitudeCount,u'无',

u'无',Rank,0,isRelease)

except Exception,e:

print(e, page_url, value)

return None

爬虫调度器

def dynamic_crawl(self, root_url):

content = self.downloader.download(root_url)

urls = self.parser.parser_url(root_url,content)

for url in urls:

try:

t = time.strftime("%Y%m%d%H%M%S3282", time.localtime())

rank_url ='http://service.library.mtime.com/Movie.api'\

'?Ajax_CallBack=true'\

'&Ajax_CallBackType=Mtime.Library.Services'\

'&Ajax_CallBackMethod=GetMovieOverviewRating'\

'&Ajax_CrossDomain=1'\

'&Ajax_RequestRrl=%s'\

'&t=%s'\

'&Ajax_CallBackArgument0=%s'%(url[0],t,url[1])

rank_content = self.downloader.download(rank_url)

data = self.parser.parser_json(rank_url,rank_content)

print(data)

except Exception,e:

print('Crawl failed')

if __name__=="__main__":

spider_main = SpiderMain()

spider_main.dynamic_crawl("http://theater.mtime.com/China_Beijing/") 查看全部

抓取动态网页(动态网站解析的动态网页爬取方法(组图)

)

我刚才讲的是抓取静态网页。本篇博客介绍动态网站的爬取。动态网站的爬取比静态网页更难,涉及的主要技术是Ajax和动态Html。简单的网页访问无法获取完整的数据,需要分析数据加载过程。将通过具体的例子来介绍不同的动态网页爬取方法。本篇博客主要使用ajax直接获取数据。

页面分析

本博客以MTime电影网为例,主要爬取电影收视率、票房等信息。首先使用火狐浏览器的控制台查看页面信息。

页面中的票房信息无法以 HTML 格式获取。是通过js动态加载得到的,然后搜索对应的js响应。就是从一堆js请求中查看一些收录ajax字段的请求。%3A%2F%%2F242129%2F&t=27406&Ajax_CallBackArgument0=242129

点击查看返回数据:

找到对应的链接并返回数据后,需要分析这个链接的构造方法,分析返回的数据。

(1)链接一共7个参数,我们首先要分析哪些参数没有变化,哪些参数在不同的电影中差异更大。通过对比两个不同的电影链接,可以发现其中4个是not 有动态变化的三个参数,分别是Ajax_RequestRrl、t和Ajax_CallBackArgument0,通过分析可以发现这三个参数分别代表当前页面url、当前请求时间、电影所代表的数量。

(2) 提取响应数据。响应内容主要分为三类,分别是正在上映的电影信息,即将上映的电影信息,最后一种是即将上映的电影信息发布很久了,详情见代码。

具体实现代码

本文代码基于博客实现。本博客只修改需要改动的部分。

网页分析

在HtmlParser类中定义一个parser_url方法,代码如下:

def parser_url(self, page_url, response):

pattern = re.compile(r'(http://movie.mtime.com/(\d+)/)')

urls = pattern.findall(response)

if urls != None:

return list(set(urls))

else:

return None

提取响应数据中的有效数据:

def parser_json(self, page_url, respone):

"""

解析响应

:param page_url:

:param respone:

:return:

"""

#将“=”和“;”之间的内容提取出来

pattern = re.compile(r'=(.*?);')

result = pattern.findall(respone)[0]

if result != None:

value = json.loads(result)

try:

isRelease = value.get('value').get('isRelease')

except Exception,e:

print(e)

return None

if isRelease:

if value.get('value').get('hotValue') == None:

return self._parser_release(page_url, value)

else:

self._parser_no_release(page_url, value, isRelease = 2)

else:

return self._parser_no_release(page_url, value)

def _parser_release(self, page_url, value):

"""

解析已上映的影片

:param page_url:

:param value:

:return:

"""

try:

isRelease = 1

movieRating = value.get('value').get('movieRating')

boxOffice = value.get('value').get('boxOffice')

movieTitle = value.get('value').get('movieTitle')

RPictureFinal = movieRating.get('RPictureFinal')

RStoryFinal = movieRating.get('RStoryFinal')

RDirectorFinal = movieRating.get('RDirectorFinal')

ROtherFinal = movieRating.get('ROtherFinal')

RatingFinal = movieRating.get('RatingFinal')

MovieId = movieRating.get('MovieId')

Usercount = movieRating.get('Usercount')

AttitudeCount = movieRating.get('AttitudeCount')

TotalBoxOffice = boxOffice.get('TotalBoxOffice')

TotalBoxOfficeUnit = boxOffice.get('TotalBoxOfficeUnit')

TodayBoxOffice = boxOffice.get('TodayBoxOffice')

TodayBoxOfficeUnit = boxOffice.get('TodayBoxOfficeUnit')

showDays = boxOffice.get('ShowDays')

try:

Rank = boxOffice.get('Rank')

except Exception,e:

Rank = 0

return (MovieId,movieTitle,RatingFinal,

ROtherFinal,RPictureFinal,RDirectorFinal,

RStoryFinal,Usercount,AttitudeCount,

TotalBoxOffice+TotalBoxOfficeUnit,

TodayBoxOffice+TodayBoxOfficeUnit,

Rank,showDays,isRelease)

except Exception,e:

print(e,page_url,value)

return None

def _parser_no_release(self,page_url,value,isRelease = 0):

try:

movieRating = value.get('value').get('movieRating')

movieTitle = value.get('value').get('movieTitle')

RPictureFinal = movieRating.get('RPictureFinal')

RStoryFinal = movieRating.get('RStoryFinal')

RDirectorFinal = movieRating.get('RDirectorFinal')

ROtherFinal = movieRating.get('ROtherFinal')

RatingFinal = movieRating.get('RatingFinal')

MovieId = movieRating.get('MovieId')

Usercount = movieRating.get('Usercount')

AttitudeCount = movieRating.get('AttitudeCount')

try:

Rank = value.get('value').get('hotValue').get('Ranking')

except Exception,e:

Rank = 0

return (MovieId,movieTitle,RatingFinal,

ROtherFinal,RPictureFinal,RDirectorFinal,

RStoryFinal,Usercount,AttitudeCount,u'无',

u'无',Rank,0,isRelease)

except Exception,e:

print(e, page_url, value)

return None

爬虫调度器

def dynamic_crawl(self, root_url):

content = self.downloader.download(root_url)

urls = self.parser.parser_url(root_url,content)

for url in urls:

try:

t = time.strftime("%Y%m%d%H%M%S3282", time.localtime())

rank_url ='http://service.library.mtime.com/Movie.api'\

'?Ajax_CallBack=true'\

'&Ajax_CallBackType=Mtime.Library.Services'\

'&Ajax_CallBackMethod=GetMovieOverviewRating'\

'&Ajax_CrossDomain=1'\

'&Ajax_RequestRrl=%s'\

'&t=%s'\

'&Ajax_CallBackArgument0=%s'%(url[0],t,url[1])

rank_content = self.downloader.download(rank_url)

data = self.parser.parser_json(rank_url,rank_content)

print(data)

except Exception,e:

print('Crawl failed')

if __name__=="__main__":

spider_main = SpiderMain()

spider_main.dynamic_crawl("http://theater.mtime.com/China_Beijing/";)

抓取动态网页(准备工作python基础入门jupyternotebook自动补全代码request_html )

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-09-28 07:22

)

准备好工作了

开始使用 Python 基础知识

Jupyter notebook 自动补全代码

request_html 是python3中的一个包,python2不能用

在pycharm中导入第三方包

使用python爬取数据(pyhton2)

网络爬虫是一种自动从 Internet 获取数据的程序。基本上我们在浏览网站时看到的所有数据都可以通过爬虫程序保存下来。我们可以学习爬虫来获取相关数据。但是,数据是可归属的,而不是你想使用的,所以我们需要在合法的情况下使用爬虫。因此,我们必须遵守互联网世界的机器人协议。引自爬虫的介绍

1.请求抓取静态网页

import requests

from lxml import etree

aaa=requests.get("https://blog.csdn.net/IT_XF/ar ... 6quot;)

bbb=etree.HTML(aaa.text)

ccc=aaa.xpath('//*[@id="content_views"]/p/text()')

for each in bbb:

print (each)

按照上面的代码爬取网页中的文字内容

2. 模拟登录

参考资料:

(1)在浏览器中获取cookie字符串

服务器使用 cookie 来区分不同的客户端。当服务器一次收到多个请求时,它无法分辨哪些请求是由同一个客户端发起的。因此,cookie是向服务器端向客户端证明:“我是刚刚登录的客户端”。这意味着只要我们从另一个客户端获取 cookie,我们就可以伪造它与服务器通信。

通过抓包获取cookie,然后将cookie放入请求中发送请求:

完成

# -*- coding: utf-8 -*-

#python2

import urllib2

aaa={"cookie":'在浏览器中找到的目标网址的cookie'}

url='https://i.csdn.net/#/uc/profile'

bbb=urllib2.Request(url,headers=aaa)

ccc=urllib2.urlopen(bbb).read()

print ccc

#python2

import requests

aaa={"cookie":'在浏览器中找到的目标网址的cookie'

ccc=requests.get(bbb,headers=aaa)

print ccc.text

(2)

上面的方法是可行的,但是太麻烦了。我们首先需要在浏览器中登录账号,设置保存密码,通过抓包获取这个cookie。让我们尝试使用会话。

会话的意思是会话。与 cookie 的相似之处在于它也允许服务器“识别”客户端。简单的理解是,客户端和服务器之间的每一次交互都被视为一个“会话”。既然是在同一个“会话”中,服务器自然会知道客户端是否登录了。

(3).使用Selenium和PhantomJS模拟登录

以上两个是使用的请求。requests 模块是一个不完全模拟浏览器行为的模块。它只能抓取网页的 HTML 文档信息,不能解析和执行 CSS 和 JavaScript 代码。这是它的缺点。

下面我们用selenium来处理上面的问题

selenium模块的本质是驱动浏览器完全模拟浏览器的操作,如跳转、输入、点击、下拉等,得到网页渲染的结果,可以支持多种浏览器;(因为 selenium 解析并执行 CSS、JavaScript,所以它的性能相对于请求来说是低的;)

import time

import selenium

aaa=webdriver.Chrome() #生成chrome浏览器对象

#bbb=WebDriverWait(aaa,10) #浏览器加载完毕的最大等待时间,设置为10秒

try:

aaa.get('https://www.baidu.com/') #打开百度网页

ccc=aaa.find_element_by_id("kw")

ddd=ccc.send_keys('张根硕')

eee_button=aaa.find_element_by_id('su')

eee_button.click()

print(aaa.page_source)

#wait.until(EC.presence_of_element_located((By.ID,'4')))

finally:

time.sleep(100)#页面存在的时长100s

aaa.close()

3.使用selenum动态爬虫

参考:

4. 静态抓取网页并输入到csv

利用 urlib 库和 csv 库 + BeautifulSoup

<p># -*- coding: utf-8 -*-

import urllib

from bs4 import BeautifulSoup

import csv

import codecs

#i = 1

#while i 查看全部

抓取动态网页(准备工作python基础入门jupyternotebook自动补全代码request_html

)

准备好工作了

开始使用 Python 基础知识

Jupyter notebook 自动补全代码

request_html 是python3中的一个包,python2不能用

在pycharm中导入第三方包

使用python爬取数据(pyhton2)

网络爬虫是一种自动从 Internet 获取数据的程序。基本上我们在浏览网站时看到的所有数据都可以通过爬虫程序保存下来。我们可以学习爬虫来获取相关数据。但是,数据是可归属的,而不是你想使用的,所以我们需要在合法的情况下使用爬虫。因此,我们必须遵守互联网世界的机器人协议。引自爬虫的介绍

1.请求抓取静态网页

import requests

from lxml import etree

aaa=requests.get("https://blog.csdn.net/IT_XF/ar ... 6quot;)

bbb=etree.HTML(aaa.text)

ccc=aaa.xpath('//*[@id="content_views"]/p/text()')

for each in bbb:

print (each)

按照上面的代码爬取网页中的文字内容

2. 模拟登录

参考资料:

(1)在浏览器中获取cookie字符串

服务器使用 cookie 来区分不同的客户端。当服务器一次收到多个请求时,它无法分辨哪些请求是由同一个客户端发起的。因此,cookie是向服务器端向客户端证明:“我是刚刚登录的客户端”。这意味着只要我们从另一个客户端获取 cookie,我们就可以伪造它与服务器通信。

通过抓包获取cookie,然后将cookie放入请求中发送请求:

完成

# -*- coding: utf-8 -*-

#python2

import urllib2

aaa={"cookie":'在浏览器中找到的目标网址的cookie'}

url='https://i.csdn.net/#/uc/profile'

bbb=urllib2.Request(url,headers=aaa)

ccc=urllib2.urlopen(bbb).read()

print ccc

#python2

import requests

aaa={"cookie":'在浏览器中找到的目标网址的cookie'

ccc=requests.get(bbb,headers=aaa)

print ccc.text

(2)

上面的方法是可行的,但是太麻烦了。我们首先需要在浏览器中登录账号,设置保存密码,通过抓包获取这个cookie。让我们尝试使用会话。

会话的意思是会话。与 cookie 的相似之处在于它也允许服务器“识别”客户端。简单的理解是,客户端和服务器之间的每一次交互都被视为一个“会话”。既然是在同一个“会话”中,服务器自然会知道客户端是否登录了。

(3).使用Selenium和PhantomJS模拟登录

以上两个是使用的请求。requests 模块是一个不完全模拟浏览器行为的模块。它只能抓取网页的 HTML 文档信息,不能解析和执行 CSS 和 JavaScript 代码。这是它的缺点。

下面我们用selenium来处理上面的问题

selenium模块的本质是驱动浏览器完全模拟浏览器的操作,如跳转、输入、点击、下拉等,得到网页渲染的结果,可以支持多种浏览器;(因为 selenium 解析并执行 CSS、JavaScript,所以它的性能相对于请求来说是低的;)

import time

import selenium

aaa=webdriver.Chrome() #生成chrome浏览器对象

#bbb=WebDriverWait(aaa,10) #浏览器加载完毕的最大等待时间,设置为10秒

try:

aaa.get('https://www.baidu.com/') #打开百度网页

ccc=aaa.find_element_by_id("kw")

ddd=ccc.send_keys('张根硕')

eee_button=aaa.find_element_by_id('su')

eee_button.click()

print(aaa.page_source)

#wait.until(EC.presence_of_element_located((By.ID,'4')))

finally:

time.sleep(100)#页面存在的时长100s

aaa.close()

3.使用selenum动态爬虫

参考:

4. 静态抓取网页并输入到csv

利用 urlib 库和 csv 库 + BeautifulSoup

<p># -*- coding: utf-8 -*-

import urllib

from bs4 import BeautifulSoup

import csv

import codecs

#i = 1

#while i

抓取动态网页(抓取静态页面中的数据都包含在网页的HTML中 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2021-09-27 20:05

)

抓取静态页面。静态页面中的数据收录在网页的HTML中(通常是get请求)

所需的包解释

请求是常见的网络请求包

Lxml解析生成XML对象

XPath是一种用于在XML文档中查找信息的语言

静态网页捕获文章(网易新闻)

我们以网易新闻的一个新闻页面为例文章capture

下面的代码解析网易文章并存储它。它是通过XPath解析从网页的静态源代码中获得的

#coding=utf-8

import requests

from lxml import etree

import json

class WangyiCollect():

def __init__(self,url):

self.url = url

def responseHtml(self):

#获取网页源码

content = requests.get(url=self.url).text

#初始化生成一个XPath解析对象

html = etree.HTML(content)

#提取文章页内容,采用xpath解析方式

title = html.xpath('//h1/text()')[0]

pubTime = html.xpath('//div[@class="post_time_source"]/text()')[0].replace('来源:', '').strip()

pubSource = html.xpath('//a[@id="ne_article_source"]/text()')[0]

contentList = html.xpath('//div[@id="endText"]/p//text() | //div[@id="endText"]//img/@src')

newContentList = []

for paragraph in contentList:

newparagraph = paragraph

if paragraph.endswith('.jpg') or paragraph.endswith('.png') or paragraph.endswith('.gif') or paragraph.startswith('http'):newparagraph = '

' + paragraph + '<br /><br />'

newContentList.append(newparagraph)

content = ''.join(newContentList)

#存储文章内容,存储格式为json格式

articleJson = {}

articleJson['title'] = title

articleJson['pubTime'] = pubTime

articleJson['pubSource'] = pubSource

articleJson['content'] = content

print(json.dumps(articleJson,ensure_ascii=False))

#之前为字典,需要转成json的字符串

strArticleJson = json.dumps(articleJson,ensure_ascii=False)

self.writeFile(strArticleJson)

#写入文本文件

def writeFile(self,text):

file = open('./wangyiArticle.txt','a',encoding='utf-8')

file.write(text+'\n')

if __name__=="__main__":

wangyiCollect = WangyiCollect('http://bj.news.163.com/19/0731/10/ELDHE9I604388CSB.html')

wangyiCollect.responseHtml()

抓取动态加载的网页

结构化数据:JSON、XML等

动态页面和静态页面之间的主要区别在于在刷新数据时使用Ajax技术。刷新数据时,将从数据库中查询数据并重新呈现到前端页面。数据存储在网络包中,无法通过爬行HTML获取数据

获取此动态页面有两种常见方法:

1.抓取网络请求包,请求接口传递一些参数,并破解参数。这将写在未来的博客,破解JS和破解参数

image.png

您可以看到右侧网络包中的文章数据是通过chrome数据包捕获通过数据包传输的

取出网络包的地址请求数据,它是JSON格式的数据片段

{

"title":"智能垃圾回收机重启 居民区里遇冷",

"digest":"",

"docurl":"[http://bj.news.163.com/19/0729 ... .html](http://bj.news.163.com/19/0729 ... B.html)",

"commenturl":"[http://comment.tie.163.com/EL8DU15104388CSB.html](http://comment.tie.163.com/EL8DU15104388CSB.html)",

"tienum":"0",

"tlastid":"",

"tlink":"",

"label":"",

"keywords":[

{

"akey_link":"/keywords/5/0/5c0f9ec472d7/1.html",

"keyname":"小黄狗"

},

{

"akey_link":"/keywords/5/d/56de6536673a/1.html",

"keyname":"回收机"

}

],

"time":"07/29/2019 10:39:26",

"newstype":"article",

"imgurl":"[http://cms-bucket.ws.126.net/2 ... .jpeg](http://cms-bucket.ws.126.net/2 ... 8.jpeg)",

"add1":"",

"add2":"",

"add3":"",

"pics3":[

],

"channelname":"bendi"

}

获取JSON数据

#coding=utf-8

import requests,json

content = requests.get('https://house.163.com/special/00078GU7/beijign_xw_news_v1_02.js?callback=data_callback').text

#取出来的为json字符串

jsonArticle = content.split('data_callback(')[1].rstrip(')')

#将json字符串转为字典格式

dictArticleList = json.loads(jsonArticle)

for dictArticle in dictArticleList:

#取出title

title = dictArticle['title']

print(title)

2.无头浏览器渲染

硒+铬

#coding=utf-8

from selenium import webdriver

Chrome_options = webdriver.ChromeOptions()

Chrome_options.add_argument('--headless')

drive = webdriver.Chrome(chrome_options=Chrome_options)

drive.get('http://public.163.com/#/list/movie')

html = drive.page_source

print(html)

drive.quit() 查看全部

抓取动态网页(抓取静态页面中的数据都包含在网页的HTML中

)

抓取静态页面。静态页面中的数据收录在网页的HTML中(通常是get请求)

所需的包解释

请求是常见的网络请求包

Lxml解析生成XML对象

XPath是一种用于在XML文档中查找信息的语言

静态网页捕获文章(网易新闻)

我们以网易新闻的一个新闻页面为例文章capture

下面的代码解析网易文章并存储它。它是通过XPath解析从网页的静态源代码中获得的

#coding=utf-8

import requests

from lxml import etree

import json

class WangyiCollect():

def __init__(self,url):

self.url = url

def responseHtml(self):

#获取网页源码

content = requests.get(url=self.url).text

#初始化生成一个XPath解析对象

html = etree.HTML(content)

#提取文章页内容,采用xpath解析方式

title = html.xpath('//h1/text()')[0]

pubTime = html.xpath('//div[@class="post_time_source"]/text()')[0].replace('来源:', '').strip()

pubSource = html.xpath('//a[@id="ne_article_source"]/text()')[0]

contentList = html.xpath('//div[@id="endText"]/p//text() | //div[@id="endText"]//img/@src')

newContentList = []

for paragraph in contentList:

newparagraph = paragraph

if paragraph.endswith('.jpg') or paragraph.endswith('.png') or paragraph.endswith('.gif') or paragraph.startswith('http'):newparagraph = '

' + paragraph + '<br /><br />'

newContentList.append(newparagraph)

content = ''.join(newContentList)

#存储文章内容,存储格式为json格式

articleJson = {}

articleJson['title'] = title

articleJson['pubTime'] = pubTime

articleJson['pubSource'] = pubSource

articleJson['content'] = content

print(json.dumps(articleJson,ensure_ascii=False))

#之前为字典,需要转成json的字符串

strArticleJson = json.dumps(articleJson,ensure_ascii=False)

self.writeFile(strArticleJson)

#写入文本文件

def writeFile(self,text):

file = open('./wangyiArticle.txt','a',encoding='utf-8')

file.write(text+'\n')

if __name__=="__main__":

wangyiCollect = WangyiCollect('http://bj.news.163.com/19/0731/10/ELDHE9I604388CSB.html')

wangyiCollect.responseHtml()

抓取动态加载的网页

结构化数据:JSON、XML等

动态页面和静态页面之间的主要区别在于在刷新数据时使用Ajax技术。刷新数据时,将从数据库中查询数据并重新呈现到前端页面。数据存储在网络包中,无法通过爬行HTML获取数据

获取此动态页面有两种常见方法:

1.抓取网络请求包,请求接口传递一些参数,并破解参数。这将写在未来的博客,破解JS和破解参数

image.png

您可以看到右侧网络包中的文章数据是通过chrome数据包捕获通过数据包传输的

取出网络包的地址请求数据,它是JSON格式的数据片段

{

"title":"智能垃圾回收机重启 居民区里遇冷",

"digest":"",

"docurl":"[http://bj.news.163.com/19/0729 ... .html](http://bj.news.163.com/19/0729 ... B.html)",

"commenturl":"[http://comment.tie.163.com/EL8DU15104388CSB.html](http://comment.tie.163.com/EL8DU15104388CSB.html)",

"tienum":"0",

"tlastid":"",

"tlink":"",

"label":"",

"keywords":[

{

"akey_link":"/keywords/5/0/5c0f9ec472d7/1.html",

"keyname":"小黄狗"

},

{

"akey_link":"/keywords/5/d/56de6536673a/1.html",

"keyname":"回收机"

}

],

"time":"07/29/2019 10:39:26",

"newstype":"article",

"imgurl":"[http://cms-bucket.ws.126.net/2 ... .jpeg](http://cms-bucket.ws.126.net/2 ... 8.jpeg)",

"add1":"",

"add2":"",

"add3":"",

"pics3":[

],

"channelname":"bendi"

}

获取JSON数据

#coding=utf-8

import requests,json

content = requests.get('https://house.163.com/special/00078GU7/beijign_xw_news_v1_02.js?callback=data_callback').text

#取出来的为json字符串

jsonArticle = content.split('data_callback(')[1].rstrip(')')

#将json字符串转为字典格式

dictArticleList = json.loads(jsonArticle)

for dictArticle in dictArticleList:

#取出title

title = dictArticle['title']

print(title)

2.无头浏览器渲染

硒+铬

#coding=utf-8

from selenium import webdriver

Chrome_options = webdriver.ChromeOptions()

Chrome_options.add_argument('--headless')

drive = webdriver.Chrome(chrome_options=Chrome_options)

drive.get('http://public.163.com/#/list/movie')

html = drive.page_source

print(html)

drive.quit()

抓取动态网页(一下动态网站快讯 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-09-27 20:03

)

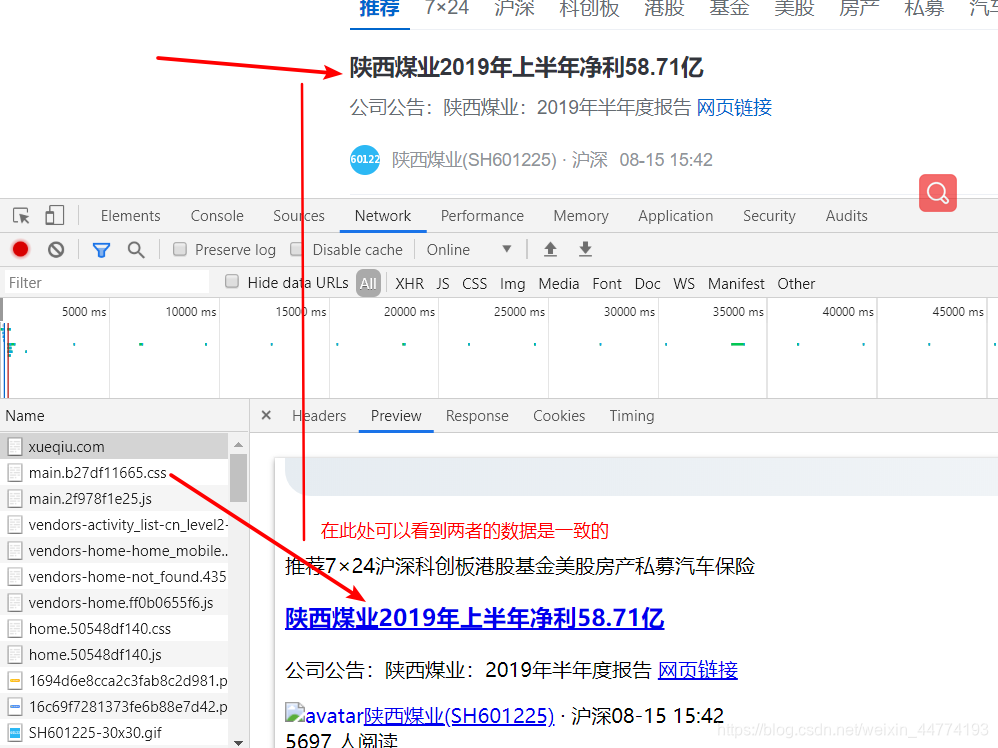

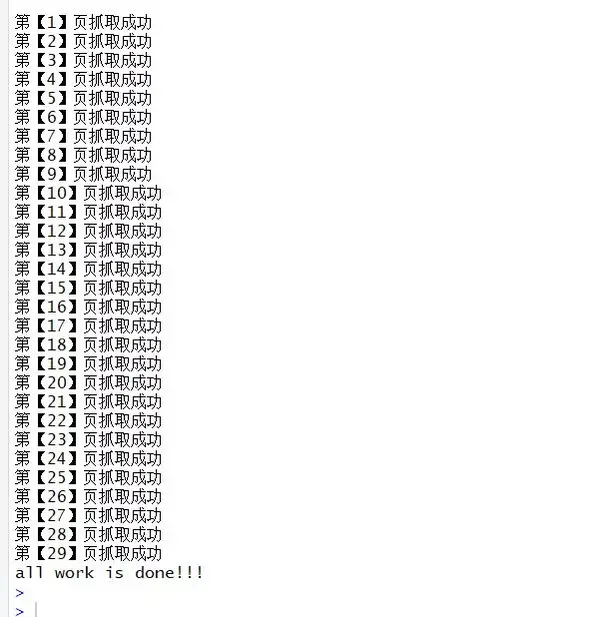

今天研究了一下动态网站的爬取,以及这里使用的世轩股票宝网站:

这个小案例简单抓取了轩宝的7x24时事通讯的信息内容,并将数据保存在Mysql数据库中。

网页分为静态网页和动态网页。静态网页一般是指不与嵌入在页面或js中的后端数据交互的网页,而动态网页通过Ajax与数据库交互,可以实时从数据库中获取数据并显示在页面上.

如何判断一个网站是动态的网站:

1. 浏览网页时,部分网站可以在翻页的同时不断向下滚动和加载数据。这通常是动态的网站。

2. 也可以在网络上查看XHR,在浏览器控制台查看和后台数据交互记录。

首先,我们必须找到数据源。经过观察,我们发现时事通讯是由上图中名为newsflash的请求加载的。通过这个请求,我们可以得到他的url,10,723,35,469,821&platform=pcweb。通过观察这个请求,我们可以找到newsflashlimit参数控制请求。返回的记录数,游标是毫秒时间戳,因为这里的咨询内容是动态更新的,每隔一段时间就会加载新的咨询,这里是按时间排序的,所以只要控制这两个参数就可以得到咨询你想要的内容。

这里我尝试抓取一个时间段内的咨询内容,时间间隔设置为10分钟。也就是说,每次咨询内容在10分钟内生成,当然可能会有重复,这里就不做处理了。

用于时间戳和时间转换的在线工具:

代码显示如下

#!/usr/bin/env python

# -*- 编码:utf-8 -*-

# @File: 蜘蛛侠.py

# @Author: 小橙

# @日期:2019-1-6

# @Desc :Dynamic 网站 抓取选择共享

进口请求

从 fake_useragent 导入 UserAgent

从 sqlalchemy 导入 create_engine

将熊猫导入为 pd

导入时间

#时间:1月7日12:00-17:00

#对应时间戳:00-00

#发送请求获取返回数据

定义获取数据(网址):

如果 url 为 None:

返回

ua = 用户代理()

headers = {'User-Agnet':ua.random}

r = requests.get(url,headers=headers)

如果 r.status_code == 200:

#如果请求返回的是json格式的数据,可以使用json()函数

#也可以使用json.load()函数将json格式的字符串转换成json对象

返回 r.json()

#提取返回数据中的字段信息

定义解析器数据(数据):

#提取数据中的id、title、汇总字段信息

retdata = data.get('数据')

msglist = retdata.get('消息')

保存列表 = []

对于 msglist 中的 msg:

id = int(msg.get('id'))

title = msg.get('title')

总结 =''

#summary中的字段为空时,将title的值赋给summary

如果 msg.get('summary') !='':

summary = msg.get('summary').replace('\n','')#去掉摘要中的换行符

别的:

摘要 = 标题

温度 = []

temp.append(id)

temp.append(标题)

temp.append(总结)

savelist.append(temp)

返回保存列表

#保存数据到数据库

def saveData(result_data,con):

#向数据库写入数据

如果 len(result_data)>0:

#这里创建DataFrame的时候忘记加header了,写数据的时候一直报错

df = pd.DataFrame(result_data,columns=['id','title','summary'])

# 打印('df:',df)

#如果要自动建表,用replace替换if_exists的值,建议自己建表,if_exists的值是append

#name是表名,con是数据库连接

df.to_sql(name="stock_news", con=con, if_exists='append', index=False)

# print('数据保存成功!')

#获取数据库连接

def getContact():

#连接数据库

engine = create_engine('mysql+pymysql://root:123456@localhost:3306/demo01?charset=utf8')

con = engine.connect()

print('Mysql 连接创建成功...')

返回引擎

如果 __name__ =='__main__':

url =';cursor={}&subj_ids=9,10,723,35,469,821&platform=pcweb'

开始时间 = 00

con = getContact() #创建数据库连接

计数 = 0

为真:

#这里设置的时间间隔是10分钟,意思是每次取消息10分钟内更新

结束时间 = 开始时间 + 600000

如果 end_time>00:

休息

开始时间 = 结束时间

now_url = url.format(end_time)

数据 = 获取数据(now_url)

time.sleep(2) #每2秒请求一次

result_data = parserData(data)

# 打印(结果数据)

保存数据(result_data,con)

计数 += len(result_data)

print('{} 数据保存成功!'.format(count))

两小时的测试更新

查看全部

抓取动态网页(一下动态网站快讯

)

今天研究了一下动态网站的爬取,以及这里使用的世轩股票宝网站:

这个小案例简单抓取了轩宝的7x24时事通讯的信息内容,并将数据保存在Mysql数据库中。

网页分为静态网页和动态网页。静态网页一般是指不与嵌入在页面或js中的后端数据交互的网页,而动态网页通过Ajax与数据库交互,可以实时从数据库中获取数据并显示在页面上.

如何判断一个网站是动态的网站:

1. 浏览网页时,部分网站可以在翻页的同时不断向下滚动和加载数据。这通常是动态的网站。

2. 也可以在网络上查看XHR,在浏览器控制台查看和后台数据交互记录。

首先,我们必须找到数据源。经过观察,我们发现时事通讯是由上图中名为newsflash的请求加载的。通过这个请求,我们可以得到他的url,10,723,35,469,821&platform=pcweb。通过观察这个请求,我们可以找到newsflashlimit参数控制请求。返回的记录数,游标是毫秒时间戳,因为这里的咨询内容是动态更新的,每隔一段时间就会加载新的咨询,这里是按时间排序的,所以只要控制这两个参数就可以得到咨询你想要的内容。

这里我尝试抓取一个时间段内的咨询内容,时间间隔设置为10分钟。也就是说,每次咨询内容在10分钟内生成,当然可能会有重复,这里就不做处理了。

用于时间戳和时间转换的在线工具:

代码显示如下

#!/usr/bin/env python

# -*- 编码:utf-8 -*-

# @File: 蜘蛛侠.py

# @Author: 小橙

# @日期:2019-1-6

# @Desc :Dynamic 网站 抓取选择共享

进口请求

从 fake_useragent 导入 UserAgent

从 sqlalchemy 导入 create_engine

将熊猫导入为 pd

导入时间

#时间:1月7日12:00-17:00

#对应时间戳:00-00

#发送请求获取返回数据

定义获取数据(网址):

如果 url 为 None:

返回

ua = 用户代理()

headers = {'User-Agnet':ua.random}

r = requests.get(url,headers=headers)

如果 r.status_code == 200:

#如果请求返回的是json格式的数据,可以使用json()函数

#也可以使用json.load()函数将json格式的字符串转换成json对象

返回 r.json()

#提取返回数据中的字段信息

定义解析器数据(数据):

#提取数据中的id、title、汇总字段信息

retdata = data.get('数据')

msglist = retdata.get('消息')

保存列表 = []

对于 msglist 中的 msg:

id = int(msg.get('id'))

title = msg.get('title')

总结 =''

#summary中的字段为空时,将title的值赋给summary

如果 msg.get('summary') !='':

summary = msg.get('summary').replace('\n','')#去掉摘要中的换行符

别的:

摘要 = 标题

温度 = []

temp.append(id)

temp.append(标题)

temp.append(总结)

savelist.append(temp)

返回保存列表

#保存数据到数据库

def saveData(result_data,con):

#向数据库写入数据

如果 len(result_data)>0:

#这里创建DataFrame的时候忘记加header了,写数据的时候一直报错

df = pd.DataFrame(result_data,columns=['id','title','summary'])

# 打印('df:',df)

#如果要自动建表,用replace替换if_exists的值,建议自己建表,if_exists的值是append

#name是表名,con是数据库连接

df.to_sql(name="stock_news", con=con, if_exists='append', index=False)

# print('数据保存成功!')

#获取数据库连接

def getContact():

#连接数据库

engine = create_engine('mysql+pymysql://root:123456@localhost:3306/demo01?charset=utf8')

con = engine.connect()

print('Mysql 连接创建成功...')

返回引擎

如果 __name__ =='__main__':

url =';cursor={}&subj_ids=9,10,723,35,469,821&platform=pcweb'

开始时间 = 00

con = getContact() #创建数据库连接

计数 = 0

为真:

#这里设置的时间间隔是10分钟,意思是每次取消息10分钟内更新

结束时间 = 开始时间 + 600000

如果 end_time>00:

休息

开始时间 = 结束时间

now_url = url.format(end_time)

数据 = 获取数据(now_url)

time.sleep(2) #每2秒请求一次

result_data = parserData(data)

# 打印(结果数据)

保存数据(result_data,con)

计数 += len(result_data)

print('{} 数据保存成功!'.format(count))

两小时的测试更新

抓取动态网页(什么是Ajax即“AsynchronousJavascript”(异步JavaScript和XML) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-09-27 15:23

)

什么是阿贾克斯

Ajax 代表“Asynchronous Javascript And XML”(异步 JavaScript 和 XML),指的是一种用于创建交互式 Web 应用程序的 Web 开发技术。Ajax 是一种无需重新加载整个网页即可更新网页的一部分的技术。通过在后台与服务器交换少量数据,Ajax 可以使网页异步更新。这意味着可以在不重新加载整个网页的情况下更新网页的某些部分。使用ajax加载的数据,即使使用js将数据渲染到浏览器中,在右键查看网页源码中仍然看不到通过ajax加载的数据,只有使用这个url加载的html代码.

获取ajax数据的方法直接分析ajax调用的接口,然后通过代码请求这个接口。使用Selenium+chromedriver模拟浏览器获取数据的行为。的优点和缺点

分析界面

可以直接请求数据。无需做一些分析工作。代码少,性能高

解析接口比较复杂,尤其是通过一些js混淆的接口,必须有一定的js基础。容易被发现的粪便爬虫

硒

直接模拟浏览器行为。爬虫更稳定

代码量大,性能低

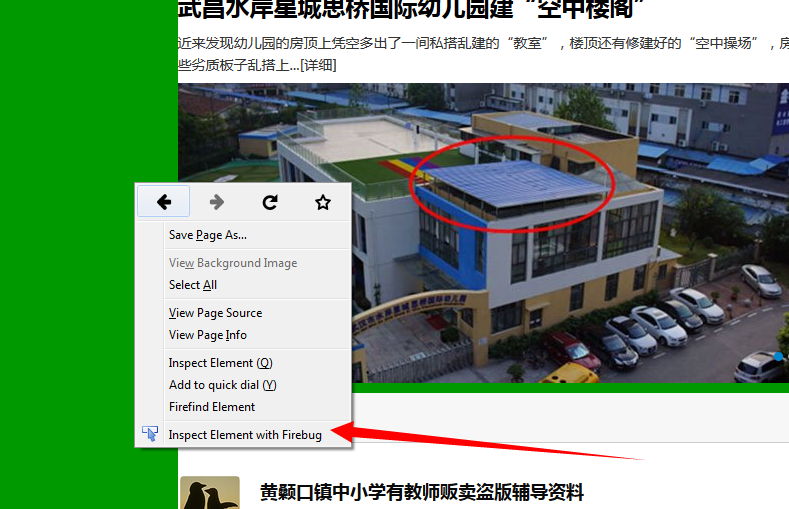

注:异步加载的数据不会显示在原创网页代码中,但您可以使用查看器进行选择查看,然后可以在 Elements 属性中查看代码的标签结构,方便后续数据分析。

另外也可以在Network中找到对应的异步加载的数据,然后根据响应获取json数据,然后在线分析得到规范化的json数据。

查看全部

抓取动态网页(什么是Ajax即“AsynchronousJavascript”(异步JavaScript和XML)

)

什么是阿贾克斯

Ajax 代表“Asynchronous Javascript And XML”(异步 JavaScript 和 XML),指的是一种用于创建交互式 Web 应用程序的 Web 开发技术。Ajax 是一种无需重新加载整个网页即可更新网页的一部分的技术。通过在后台与服务器交换少量数据,Ajax 可以使网页异步更新。这意味着可以在不重新加载整个网页的情况下更新网页的某些部分。使用ajax加载的数据,即使使用js将数据渲染到浏览器中,在右键查看网页源码中仍然看不到通过ajax加载的数据,只有使用这个url加载的html代码.

获取ajax数据的方法直接分析ajax调用的接口,然后通过代码请求这个接口。使用Selenium+chromedriver模拟浏览器获取数据的行为。的优点和缺点

分析界面

可以直接请求数据。无需做一些分析工作。代码少,性能高

解析接口比较复杂,尤其是通过一些js混淆的接口,必须有一定的js基础。容易被发现的粪便爬虫

硒

直接模拟浏览器行为。爬虫更稳定

代码量大,性能低

注:异步加载的数据不会显示在原创网页代码中,但您可以使用查看器进行选择查看,然后可以在 Elements 属性中查看代码的标签结构,方便后续数据分析。

另外也可以在Network中找到对应的异步加载的数据,然后根据响应获取json数据,然后在线分析得到规范化的json数据。

抓取动态网页(完整的使用方式如下最近更新Workflow命令行帮助工具(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2021-09-26 18:30

现在越来越多的网页使用前端渲染页面,这给抓取工作带来了很多麻烦。通过通常的方法,只会得到一堆js方法或者api接口。当然,我们不希望每个网站都那么努力地探索他们的 api。

那有什么好办法,叫全能的谷歌老爸,puppeteer可以模拟chrome打开网页,还可以截图转换成pdf文件。当然,抓取数据不是问题,因为截图的前提是模拟前端渲染。效果就像实际打开网站。

本文文章主要介绍如何通过puppeteer进行简单爬行

下载

1

$ yarn add puppeteer

用

先看一个简单的例子,我们还是不问为什么直接运行代码

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.instagram.com/nike/');

// Get the "viewport" of the page, as reported by the page.

const dimensions = await page.evaluate(() => {

return {

width: document.documentElement.clientWidth,

height: document.documentElement.clientHeight,

title: document.title

};

});

console.log('Dimensions:', dimensions);

await browser.close();

})();

运行后,你会发现它打印出了文档的宽度、高度和标题的各个属性。现在让我们分析一下这段代码的作用。

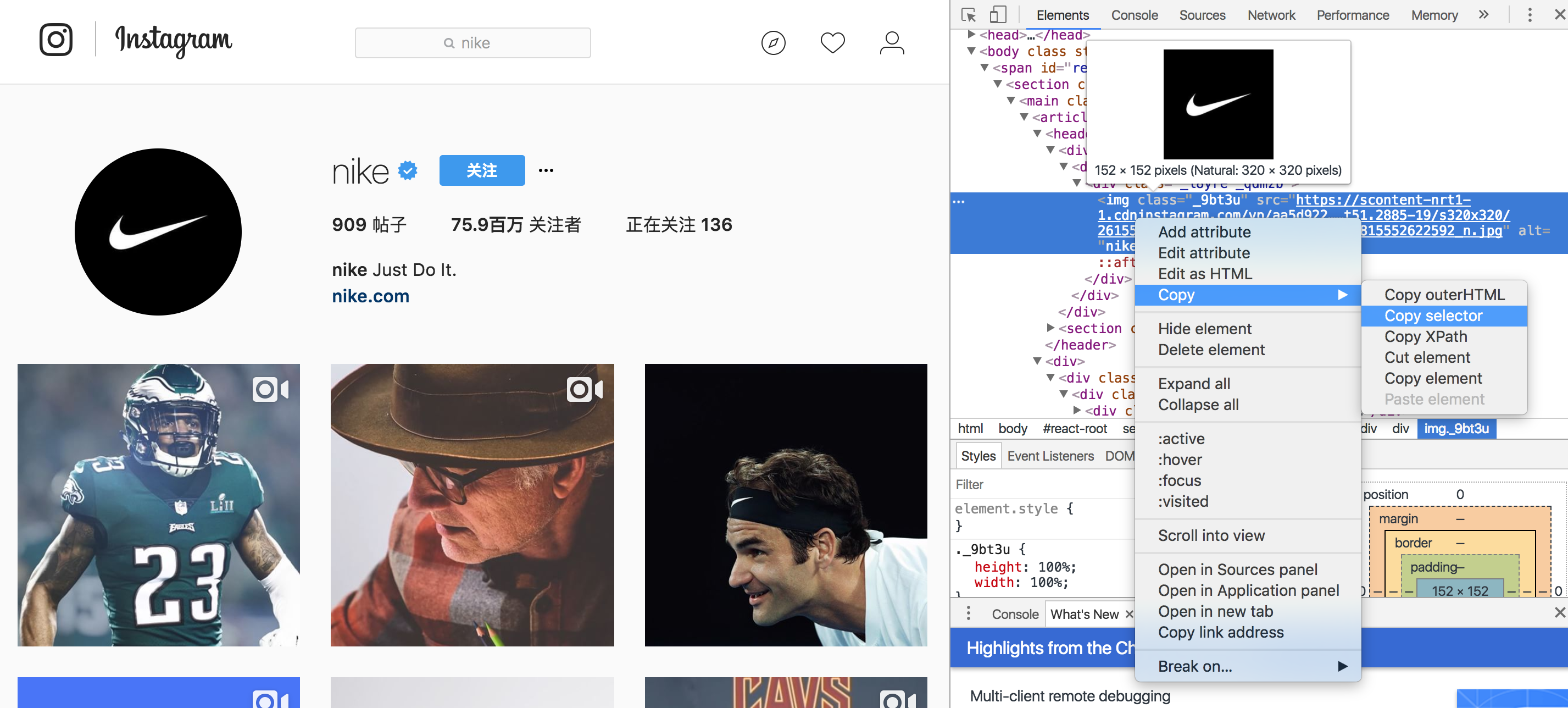

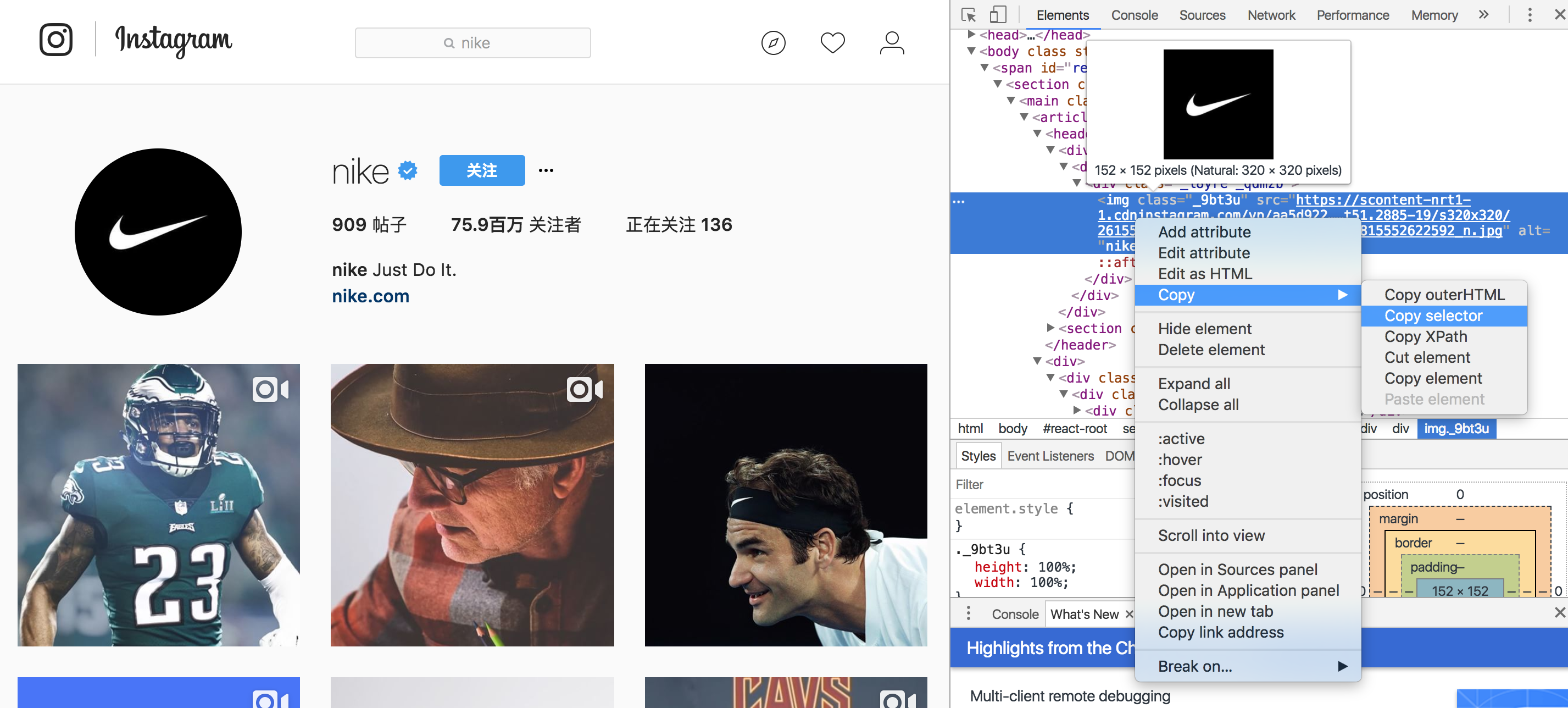

分析选择器

抓取页面时,可以借助谷歌浏览器的开发者工具直接复制选择器

我们要获取这个页面的头像信息。从开发者工具复制的选择器如下

1

#react-root > section > main > article > header > div > div > div > img

这时候我们就可以直接使用了

1

2

3

let avatarSelector = '#react-root > section > main > article > header > div > div > div > img'

let avatarDom = document.querySelector(avatarSelector)

avatar = avatarDom.src

这样我们就可以很方便的分析某个dom元素了。当然,这种粘贴复制也不是万能的。很多时候我们需要对页面样式进行分析,才能找到更好的分析方法。

完整的用法如下

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({headless: false});

const page = await browser.newPage();

await page.setJavaScriptEnabled(true);

await page.goto('https://www.instagram.com/nike/');

// Get the "viewport" of the page, as reported by the page.

const dimensions = await page.evaluate(() => {

// avatar

let avatarSelector = '#react-root > section > main > article > header > div > div > div > img'

let avatarDom = document.querySelector(avatarSelector)

let avatar = ''

if( avatarDom ){

avatar = avatarDom.src

}

// name

let nameSelector = '#react-root > section > main > article > header > section > div._ienqf > h1'

let nameDom = document.querySelector(nameSelector)

let name = ''

if( nameDom ){

name = nameDom.innerText;

}

return {

avatar: avatar,

name: name,

};

});

console.log('Dimensions:', dimensions);

await browser.close();

})();

最近更新

Alfred Workflow 命令行帮助工具

最近阅读

Go 判断数组中是否收录某项

Vim 高级功能 vimgrep 全局搜索文件

申请北京工作居留许可的一些细节

Go 语法错误:函数体外的非声明语句

Mac电脑查看字体文件位置 查看全部

抓取动态网页(完整的使用方式如下最近更新Workflow命令行帮助工具(组图))

现在越来越多的网页使用前端渲染页面,这给抓取工作带来了很多麻烦。通过通常的方法,只会得到一堆js方法或者api接口。当然,我们不希望每个网站都那么努力地探索他们的 api。

那有什么好办法,叫全能的谷歌老爸,puppeteer可以模拟chrome打开网页,还可以截图转换成pdf文件。当然,抓取数据不是问题,因为截图的前提是模拟前端渲染。效果就像实际打开网站。

本文文章主要介绍如何通过puppeteer进行简单爬行

下载

1

$ yarn add puppeteer

用

先看一个简单的例子,我们还是不问为什么直接运行代码

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.instagram.com/nike/');

// Get the "viewport" of the page, as reported by the page.

const dimensions = await page.evaluate(() => {

return {

width: document.documentElement.clientWidth,

height: document.documentElement.clientHeight,

title: document.title

};

});

console.log('Dimensions:', dimensions);

await browser.close();

})();

运行后,你会发现它打印出了文档的宽度、高度和标题的各个属性。现在让我们分析一下这段代码的作用。

分析选择器

抓取页面时,可以借助谷歌浏览器的开发者工具直接复制选择器

我们要获取这个页面的头像信息。从开发者工具复制的选择器如下

1

#react-root > section > main > article > header > div > div > div > img

这时候我们就可以直接使用了

1

2

3

let avatarSelector = '#react-root > section > main > article > header > div > div > div > img'

let avatarDom = document.querySelector(avatarSelector)

avatar = avatarDom.src

这样我们就可以很方便的分析某个dom元素了。当然,这种粘贴复制也不是万能的。很多时候我们需要对页面样式进行分析,才能找到更好的分析方法。

完整的用法如下

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({headless: false});

const page = await browser.newPage();

await page.setJavaScriptEnabled(true);

await page.goto('https://www.instagram.com/nike/');

// Get the "viewport" of the page, as reported by the page.

const dimensions = await page.evaluate(() => {

// avatar

let avatarSelector = '#react-root > section > main > article > header > div > div > div > img'

let avatarDom = document.querySelector(avatarSelector)

let avatar = ''

if( avatarDom ){

avatar = avatarDom.src

}

// name

let nameSelector = '#react-root > section > main > article > header > section > div._ienqf > h1'

let nameDom = document.querySelector(nameSelector)

let name = ''

if( nameDom ){

name = nameDom.innerText;

}

return {

avatar: avatar,

name: name,

};

});

console.log('Dimensions:', dimensions);

await browser.close();

})();

最近更新

Alfred Workflow 命令行帮助工具

最近阅读

Go 判断数组中是否收录某项

Vim 高级功能 vimgrep 全局搜索文件

申请北京工作居留许可的一些细节

Go 语法错误:函数体外的非声明语句

Mac电脑查看字体文件位置

抓取动态网页(google实现爬虫,有多种定位方法?(图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-09-23 13:34

)

这个过程更麻烦,你需要采取几步完成,你会介绍:

1.安装selenium库,可以直接使用'pip安装selenium'命令安装。

2.下载ChromedRiver并将其添加到环境变量,或直接将.exe文件放入Python安装目录脚本文件夹中。下载时,您必须选择与浏览器对应的版本。查看浏览器版本是:右上角 - &gt;帮助 - &gt;关于Google Chrome可以查看,下载驱动程序的地址是ChromedRiver下载地址,与Chrome版本相应的关系相应,验证下载和安装是否成功,只需要执行以下代码。如果没有错误,它将被成功安装。

import selenium.webdriver as driver

index = driver.Chrome()

index.get('https://www.wdzj.com/dangan')

print(index)

3.硒实现爬行动物,有多种定位方法,简要介绍:

官方网站地址是:

找到一个元素方法:

找到多个元素(返回列表)方法:

4.基本功能在你有一个快乐的爬行动物之后(因为你没有搅拌,首先把一些代码放在那里)!

import selenium.webdriver as driver

import xlwt

import types

URL = 'https://www.wdzj.com/dangan/'

# KEYWORD = '银行存管'

def key_word():

# index = driver.Chrome()

# index.get(URL)

# select_data = index.find_elements_by_xpath('//*[@id="showTable"]/ul/li/div[1]/h2/a')

# print(index.current_url)

# keyword_index = index.find_element_by_link_text()

# keyword_index.click()

names = []

banks = []

tel_nums = []

urls = []

for i in range(0, 76):

page_url = URL + 'search?filter=e1¤tPage=' + str(i + 1)

index_page = driver.Chrome()

index_page.get(page_url)

select_data = index_page.find_elements_by_xpath('//*[@id="showTable"]/ul/li/div[1]/h2/a')

print(index_page.current_url)

for data in select_data:

names.append(data.text)

print(names) #名字

sec_url = data.get_attribute("href")

index_sec = driver.Chrome()

index_sec.get(sec_url)

# print(index_sec.current_url) #链接

yhcg = index_sec.find_element_by_xpath('/html/body/div[10]/div/div[1]/div[1]/dl[1]/dd[2]/div[2]')

banks.append(yhcg.text)

# print(banks) #银行存管

tel_num = index_sec.find_element_by_link_text('联系方式')

tel_num.click()

number = index_sec.find_element_by_xpath('//*[@class="da-lxfs zzfwbox"]/dl[1]/dd[1]/div[2]')

tel_nums.append(number.text)

# print(tel_nums) #客服电话

yuming = index_sec.find_element_by_link_text('工商/备案')

yuming.click()

yu_beian = index_sec.find_element_by_xpath('//*[@class="lcen"]/table/tbody/tr[7]/td[2]')

urls.append(yu_beian.text)

print(urls) #域名

index_sec.close()

# print(page_url)

# next_page = index.find_element_by_link_text('下一页')

# next_page.click()

return names, banks, tel_nums, urls

def xls():

wb = xlwt.Workbook()

ws = wb.add_sheet('numbers')

ws.write(0, 0, '序号')

ws.write(0, 1, '公司名称')

ws.write(0, 2, '银行存管')

ws.write(0, 3, '客服电话')

ws.write(0, 4, '公司域名')

names, banks, tel_nums, urls = key_word()

print(len(names))

for i in range (0, len(names)):

ws.write(i + 1, 0, i+1)

ws.write(i + 1, 1, names[i])

ws.write(i + 1, 2, banks[i])

ws.write(i + 1, 3, tel_nums[i])

ws.write(i + 1, 4, urls[i])

wb.save('D:\\number.xls')

def run():

xls()

run()

更改:

import selenium.webdriver as driver

import xlwt

from xlutils.copy import copy

import xlrd

URL = 'https://www.wdzj.com/dangan/'

# KEYWORD = '银行存管'

def key_word():

names = []

banks = []

tel_nums = []

urls = []

count= 0

wb = xlwt.Workbook()

ws = wb.add_sheet('numbers')

ws.write(0, 0, '序号')

ws.write(0, 1, '公司名称')

ws.write(0, 2, '银行存管')

ws.write(0, 3, '客服电话')

ws.write(0, 4, '公司域名')

wb.save('D:\\number.xls')

for i in range(0, 76):

page_url = URL + 'search?filter=e1¤tPage=' + str(i + 1)

index_page = driver.Chrome()

index_page.get(page_url)

select_data = index_page.find_elements_by_xpath('//*[@id="showTable"]/ul/li/div[1]/h2/a')

print(index_page.current_url)

for data in select_data:

names.append(data.text)

print(names) #名字

sec_url = data.get_attribute("href")

index_sec = driver.Chrome()

index_sec.get(sec_url)

# print(index_sec.current_url) #链接

yhcg = index_sec.find_element_by_xpath('//*[@class="bgbox-bt zzfwbox"]/dl/dd/div[@class="r" and contains(text(),"存管")]')

banks.append(yhcg.text)

print(banks) #银行存管

tel_num = index_sec.find_element_by_link_text('联系方式')

tel_num.click()

number = index_sec.find_element_by_xpath('//*[@class="da-lxfs zzfwbox"]/dl[1]/dd[1]/div[2]')

tel_nums.append(number.text)

# print(tel_nums) #客服电话

yuming = index_sec.find_element_by_link_text('工商/备案')

yuming.click()

yu_beian = index_sec.find_element_by_xpath('//*[@class="lcen"]/table/tbody/tr[7]/td[2]')

urls.append(yu_beian.text)

print(urls) #域名

oldWb =xlrd.open_workbook('D:\\number.xls', formatting_info=True)

newWb = copy(oldWb)

news = newWb.get_sheet(0)

news.write(count + 1, 0, count + 1)

news.write(count + 1, 1, names[count])

news.write(count + 1, 2, banks[count])

news.write(count + 1, 3, tel_nums[count])

news.write(count + 1, 4, urls[count])

newWb.save('D:\\number.xls')

print(count)

count+=1

index_sec.close()

index_page.close()

return names, banks, tel_nums, urls

def run():

key_word()

run() 查看全部

抓取动态网页(google实现爬虫,有多种定位方法?(图)

)

这个过程更麻烦,你需要采取几步完成,你会介绍:

1.安装selenium库,可以直接使用'pip安装selenium'命令安装。

2.下载ChromedRiver并将其添加到环境变量,或直接将.exe文件放入Python安装目录脚本文件夹中。下载时,您必须选择与浏览器对应的版本。查看浏览器版本是:右上角 - &gt;帮助 - &gt;关于Google Chrome可以查看,下载驱动程序的地址是ChromedRiver下载地址,与Chrome版本相应的关系相应,验证下载和安装是否成功,只需要执行以下代码。如果没有错误,它将被成功安装。

import selenium.webdriver as driver

index = driver.Chrome()

index.get('https://www.wdzj.com/dangan')

print(index)

3.硒实现爬行动物,有多种定位方法,简要介绍:

官方网站地址是:

找到一个元素方法:

找到多个元素(返回列表)方法:

4.基本功能在你有一个快乐的爬行动物之后(因为你没有搅拌,首先把一些代码放在那里)!

import selenium.webdriver as driver

import xlwt

import types

URL = 'https://www.wdzj.com/dangan/'

# KEYWORD = '银行存管'

def key_word():

# index = driver.Chrome()

# index.get(URL)

# select_data = index.find_elements_by_xpath('//*[@id="showTable"]/ul/li/div[1]/h2/a')

# print(index.current_url)

# keyword_index = index.find_element_by_link_text()

# keyword_index.click()

names = []

banks = []

tel_nums = []

urls = []

for i in range(0, 76):

page_url = URL + 'search?filter=e1¤tPage=' + str(i + 1)

index_page = driver.Chrome()

index_page.get(page_url)

select_data = index_page.find_elements_by_xpath('//*[@id="showTable"]/ul/li/div[1]/h2/a')

print(index_page.current_url)

for data in select_data:

names.append(data.text)

print(names) #名字

sec_url = data.get_attribute("href")

index_sec = driver.Chrome()

index_sec.get(sec_url)

# print(index_sec.current_url) #链接

yhcg = index_sec.find_element_by_xpath('/html/body/div[10]/div/div[1]/div[1]/dl[1]/dd[2]/div[2]')

banks.append(yhcg.text)

# print(banks) #银行存管

tel_num = index_sec.find_element_by_link_text('联系方式')

tel_num.click()

number = index_sec.find_element_by_xpath('//*[@class="da-lxfs zzfwbox"]/dl[1]/dd[1]/div[2]')

tel_nums.append(number.text)

# print(tel_nums) #客服电话

yuming = index_sec.find_element_by_link_text('工商/备案')

yuming.click()

yu_beian = index_sec.find_element_by_xpath('//*[@class="lcen"]/table/tbody/tr[7]/td[2]')

urls.append(yu_beian.text)

print(urls) #域名

index_sec.close()

# print(page_url)

# next_page = index.find_element_by_link_text('下一页')

# next_page.click()

return names, banks, tel_nums, urls

def xls():

wb = xlwt.Workbook()

ws = wb.add_sheet('numbers')

ws.write(0, 0, '序号')

ws.write(0, 1, '公司名称')

ws.write(0, 2, '银行存管')

ws.write(0, 3, '客服电话')

ws.write(0, 4, '公司域名')

names, banks, tel_nums, urls = key_word()

print(len(names))

for i in range (0, len(names)):

ws.write(i + 1, 0, i+1)

ws.write(i + 1, 1, names[i])

ws.write(i + 1, 2, banks[i])

ws.write(i + 1, 3, tel_nums[i])

ws.write(i + 1, 4, urls[i])

wb.save('D:\\number.xls')

def run():

xls()

run()

更改:

import selenium.webdriver as driver

import xlwt

from xlutils.copy import copy

import xlrd

URL = 'https://www.wdzj.com/dangan/'

# KEYWORD = '银行存管'

def key_word():

names = []

banks = []

tel_nums = []

urls = []

count= 0

wb = xlwt.Workbook()

ws = wb.add_sheet('numbers')

ws.write(0, 0, '序号')

ws.write(0, 1, '公司名称')

ws.write(0, 2, '银行存管')

ws.write(0, 3, '客服电话')

ws.write(0, 4, '公司域名')

wb.save('D:\\number.xls')

for i in range(0, 76):

page_url = URL + 'search?filter=e1¤tPage=' + str(i + 1)

index_page = driver.Chrome()

index_page.get(page_url)

select_data = index_page.find_elements_by_xpath('//*[@id="showTable"]/ul/li/div[1]/h2/a')

print(index_page.current_url)

for data in select_data:

names.append(data.text)

print(names) #名字

sec_url = data.get_attribute("href")

index_sec = driver.Chrome()

index_sec.get(sec_url)

# print(index_sec.current_url) #链接

yhcg = index_sec.find_element_by_xpath('//*[@class="bgbox-bt zzfwbox"]/dl/dd/div[@class="r" and contains(text(),"存管")]')

banks.append(yhcg.text)

print(banks) #银行存管

tel_num = index_sec.find_element_by_link_text('联系方式')

tel_num.click()

number = index_sec.find_element_by_xpath('//*[@class="da-lxfs zzfwbox"]/dl[1]/dd[1]/div[2]')

tel_nums.append(number.text)

# print(tel_nums) #客服电话

yuming = index_sec.find_element_by_link_text('工商/备案')

yuming.click()

yu_beian = index_sec.find_element_by_xpath('//*[@class="lcen"]/table/tbody/tr[7]/td[2]')

urls.append(yu_beian.text)

print(urls) #域名

oldWb =xlrd.open_workbook('D:\\number.xls', formatting_info=True)

newWb = copy(oldWb)

news = newWb.get_sheet(0)

news.write(count + 1, 0, count + 1)

news.write(count + 1, 1, names[count])

news.write(count + 1, 2, banks[count])

news.write(count + 1, 3, tel_nums[count])

news.write(count + 1, 4, urls[count])

newWb.save('D:\\number.xls')

print(count)

count+=1

index_sec.close()

index_page.close()

return names, banks, tel_nums, urls

def run():

key_word()

run()

抓取动态网页(soup搜索节点操作删除节点的一种好的方法(上))

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2021-09-18 22:23

之前:本文主要介绍页面加载后如何通过JS抓取需要加载的数据和图片

本文基于Python中的selenium(pyhton包)+Chrome(谷歌浏览器)+Chrome驱动器(谷歌浏览器驱动程序)

建议下载chrome和chromdrive的最新版本(参考地址:)

还支持无头模式(无需打开浏览器)

直接代码:站点\ URL:要爬网的地址,chrome \驱动程序\路径:chromedrive存储地址

1 def get_dynamic_html(site_url):

2 print('开始加载',site_url,'动态页面')

3 chrome_options = webdriver.ChromeOptions()

4 #ban sandbox

5 chrome_options.add_argument('--no-sandbox')

6 chrome_options.add_argument('--disable-dev-shm-usage')

7 #use headless,无头模式

8 chrome_options.add_argument('--headless')

9 chrome_options.add_argument('--disable-gpu')

10 chrome_options.add_argument('--ignore-ssl-errors')

11 driver = webdriver.Chrome(executable_path=CHROME_DRIVER_PATH,chrome_options=chrome_options)

12 #print('dynamic laod web is', site_url)

13 driver.set_page_load_timeout(100)

14 #driver.set_script_timeout(100)

15 try:

16 driver.get(site_url)

17 except Exception as e:

18 #driver.execute_script('window.stop()') # 超出时间则不加载

19 print(e, 'dynamic web load timeout')

20 data = driver.page_source

21 soup = BeautifulSoup(data, 'html.parser')

22 try:

23 driver.quit()

24 except:

25 pass

26 return soup

返回一个soup,以便在此soup中搜索节点,并使用select、search、find和其他方法查找所需的节点或数据

同样,如果您想将其作为文本下载,则

1 try:

2 with open(xxx.html, 'w+', encoding="utf-8") as f:

3 #print ('html content is:',content)

4 f.write(get_dynamic_html('https://xxx.com').prettify())

5 f.close()

6 except Exception as e:

7 print(e)

让我们详细谈谈寻找美丽的汤

首先,如何导航到标签

1.use find(博主详细介绍)

2.使用选择

通过类似于jQuery的标记名、类名和ID选择器选择位置,例如soup。选择('p.Link#link1')

通过属性查找,如href、title、link和其他属性,如soup。选择('PA[href=”“]”)

这里的比赛是最小的,他的上级是

然后我们来讨论节点的操作

删除节点标记。分解

插入子节点标记。在指定位置插入(0,chlid_标记)

最后,使用靓汤是过滤滤芯的好方法。在下一章中,我们将引入正则表达式匹配来过滤爬虫内容 查看全部

抓取动态网页(soup搜索节点操作删除节点的一种好的方法(上))

之前:本文主要介绍页面加载后如何通过JS抓取需要加载的数据和图片

本文基于Python中的selenium(pyhton包)+Chrome(谷歌浏览器)+Chrome驱动器(谷歌浏览器驱动程序)

建议下载chrome和chromdrive的最新版本(参考地址:)

还支持无头模式(无需打开浏览器)

直接代码:站点\ URL:要爬网的地址,chrome \驱动程序\路径:chromedrive存储地址

1 def get_dynamic_html(site_url):

2 print('开始加载',site_url,'动态页面')

3 chrome_options = webdriver.ChromeOptions()

4 #ban sandbox

5 chrome_options.add_argument('--no-sandbox')

6 chrome_options.add_argument('--disable-dev-shm-usage')

7 #use headless,无头模式

8 chrome_options.add_argument('--headless')

9 chrome_options.add_argument('--disable-gpu')

10 chrome_options.add_argument('--ignore-ssl-errors')

11 driver = webdriver.Chrome(executable_path=CHROME_DRIVER_PATH,chrome_options=chrome_options)

12 #print('dynamic laod web is', site_url)

13 driver.set_page_load_timeout(100)

14 #driver.set_script_timeout(100)

15 try:

16 driver.get(site_url)

17 except Exception as e:

18 #driver.execute_script('window.stop()') # 超出时间则不加载

19 print(e, 'dynamic web load timeout')

20 data = driver.page_source

21 soup = BeautifulSoup(data, 'html.parser')

22 try:

23 driver.quit()

24 except:

25 pass

26 return soup

返回一个soup,以便在此soup中搜索节点,并使用select、search、find和其他方法查找所需的节点或数据

同样,如果您想将其作为文本下载,则

1 try:

2 with open(xxx.html, 'w+', encoding="utf-8") as f:

3 #print ('html content is:',content)

4 f.write(get_dynamic_html('https://xxx.com').prettify())

5 f.close()

6 except Exception as e:

7 print(e)

让我们详细谈谈寻找美丽的汤

首先,如何导航到标签

1.use find(博主详细介绍)

2.使用选择

通过类似于jQuery的标记名、类名和ID选择器选择位置,例如soup。选择('p.Link#link1')

通过属性查找,如href、title、link和其他属性,如soup。选择('PA[href=”“]”)

这里的比赛是最小的,他的上级是

然后我们来讨论节点的操作

删除节点标记。分解

插入子节点标记。在指定位置插入(0,chlid_标记)

最后,使用靓汤是过滤滤芯的好方法。在下一章中,我们将引入正则表达式匹配来过滤爬虫内容

抓取动态网页(如何用python自带urllib2库打开网页的爬虫实现之旅?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-09-18 22:21

一、背景

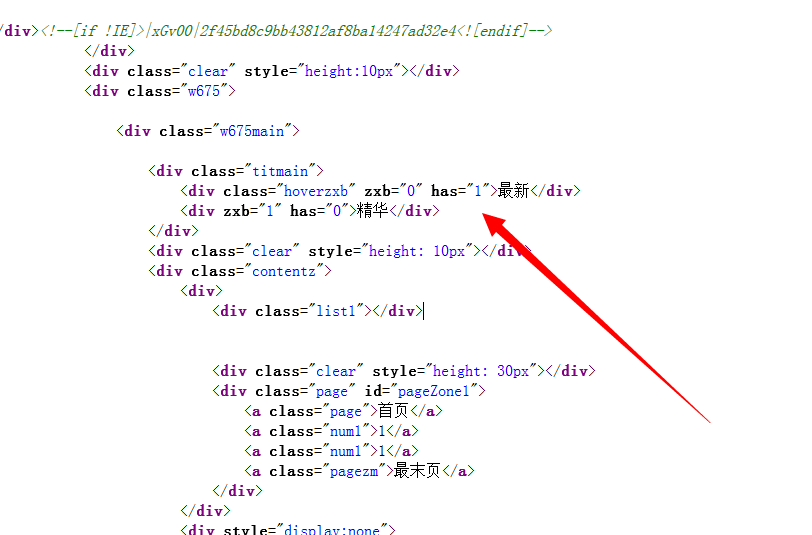

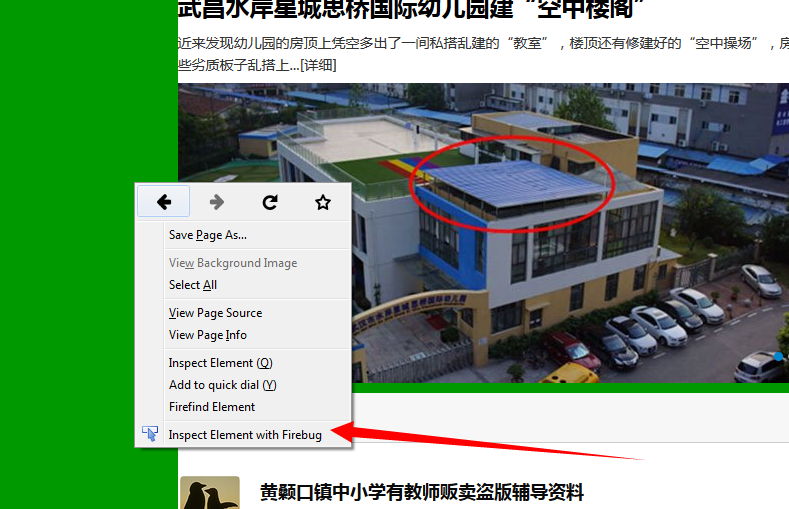

记录一次周末赶回家的爬行动物实现之旅。受他人委托,我想从这一页的明星名单上爬下来。当你在chrome中打开它时,实际上有1000条记录。然后单击“右键菜单”->;“检查”查看网页的结构,这并不特别复杂。因此,我直观地看到,只要我用Python自己的urlib2库打开网页,获取HTML代码,然后将其交给beautiful soup库解析HTML代码,我就应该能够快速完成

但是当你仔细看的时候,点击下一页,网页的URL不会改变。您只需使用js加载新数据,然后动态更改表中的数据。这与本盘的上一页不同,因此这次我们应该找到一种模拟翻页的方法,然后重新阅读新的HTML代码并对其进行分析

实现翻页有两种方法。首先是分析JS的实现,以模拟翻页。翻页操作实际上是JS向后台发送请求。在这里,它必须请求具有跳转目标页码的背景,然后获取新数据并重新呈现HTML的表部分。这种方法效率更高,但难度更大。因为如果您可以模拟请求,这意味着您已经知道其他人的服务器接口。然后,您可以通过进一步分析响应得到结果。你甚至不需要分析HTML代码,是吗?第二个相对简单的方法,也是我在这里使用的方法,是模拟单击web页面中的“下一页”按钮,然后重新读取HTML代码进行解析

二、ideas

如前所述,此处处理该想法:

在这里,打开和阅读网页的HTML代码是通过selenium实现的

解析HTML代码是通过Beauty soup实现的

三、implementation1.相关库的准备和安装

我使用Mac,因此我可以使用easy Direct_uuInstall命令行安装

1

sudo easy_install beautifulsoup4

或简易安装命令

1

sudo easy_install selenium

在这里,selenium版本已经到达3.0.2,如果要使用此版本的selenium打开网页,则需要使用相应的驱动程序。所以我需要安装一个驱动程序

我在这里使用自制安装的chromediver。安装后,请记住查找chromediver的安装目录。我们将在编写下面的代码时使用它

1

brew install chromedirver

注意:Mac下有许多软件管理包。除了我的安装方法,你可以用pip安装它们,或者直接从官方网站下载安装程序。但您必须安装上述三个程序。在这里我突然有了一个想法。老实说,如果Python拥有与gradle相同的构建管理工具,我现在花在安装这些依赖库上的时间比写代码要多

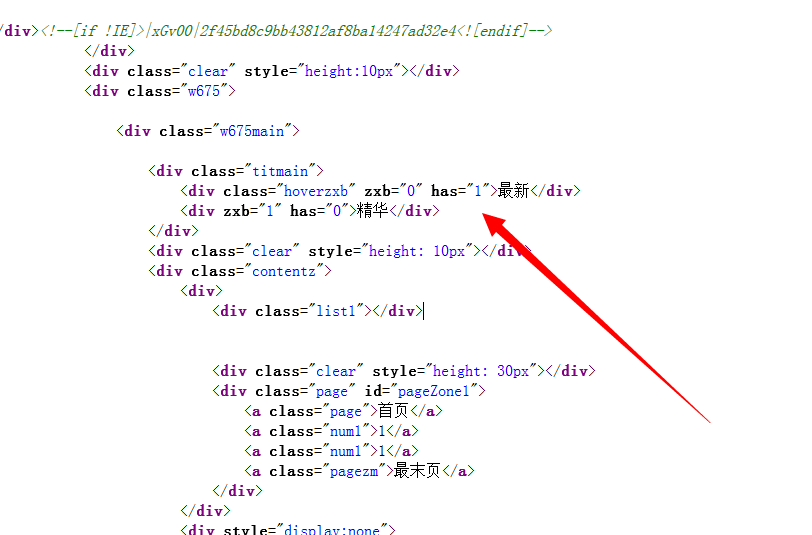

2.分析页面

只需发布我想要爬升的网页的HTML代码的一部分,在其中我使用//写一些评论:

12345678910111213141516171819202122232425262728293031323334353637383940414243444546474849505152

// 本周排行榜,这是我要抓的内容 排名 明星 鲜花数 TOP粉丝 1 // 这个td标签,star-name的css class是我要抓的内容 王俊凯 1790892 送花 1183*****630 2185*****759 3wx526298988 ...此处省略巨量代码... // 这里是本周排行榜分页的html代码,可以看到一页20个明星,共有50页 首页 尾页// 下面开始就是“上周排行榜”,html结构和上面完全类似...此处再次省略巨量代码...

3.完整代码

1234567891011121314151617181920212223242526272829303132333435

import sysimport urllib2import timefrom bs4 import BeautifulSoupfrom selenium import webdriverreload(sys)sys.setdefaultencoding('utf8') # 设置编码url = 'http://baike.baidu.com/starrank?fr=lemmaxianhua'driver = webdriver.Chrome('/usr/local/Cellar/chromedriver/2.20/bin/chromedriver') # 创建一个driver用于打开网页,记得找到brew安装的chromedriver的位置,在创建driver的时候指定这个位置driver.get(url) # 打开网页name_counter = 1page = 0;while page < 50: # 共50页,这里是手工指定的 soup = BeautifulSoup(driver.page_source, "html.parser") current_names = soup.select('div.ranking-table') # 选择器用ranking-table css class,可以取出包含本周、上周的两个table的div标签 for current_name_list in current_names: # print current_name_list['data-cat'] if current_name_list['data-cat'] == 'thisWeek': # 这次我只想抓取本周,如果想抓上周,改一下这里为lastWeek即可 names = current_name_list.select('td.star-name > a') # beautifulsoup选择器语法 counter = 0; for star_name in names: counter = counter + 1; print star_name.text # 明星的名字是a标签里面的文本,虽然a标签下面除了文本还有一个与文本同级别的img标签,但是.text输出的只是文本而已 name_counter = name_counter + 1; driver.find_element_by_xpath("//a[contains(text(),'下一页')]").click() # selenium的xpath用法,找到包含“下一页”的a标签去点击 page = page + 1 time.sleep(2) # 睡2秒让网页加载完再去读它的html代码print name_counter # 共爬取得明星的名字数量driver.quit()

四、总结

这里只简单记录了一个稍微复杂一点的网页爬行的实现思想。硒和beatifulsoup有很多用法,我没有仔细阅读。这里有一些参考资料。将来有机会我会学到更多 查看全部

抓取动态网页(如何用python自带urllib2库打开网页的爬虫实现之旅?)

一、背景

记录一次周末赶回家的爬行动物实现之旅。受他人委托,我想从这一页的明星名单上爬下来。当你在chrome中打开它时,实际上有1000条记录。然后单击“右键菜单”->;“检查”查看网页的结构,这并不特别复杂。因此,我直观地看到,只要我用Python自己的urlib2库打开网页,获取HTML代码,然后将其交给beautiful soup库解析HTML代码,我就应该能够快速完成

但是当你仔细看的时候,点击下一页,网页的URL不会改变。您只需使用js加载新数据,然后动态更改表中的数据。这与本盘的上一页不同,因此这次我们应该找到一种模拟翻页的方法,然后重新阅读新的HTML代码并对其进行分析

实现翻页有两种方法。首先是分析JS的实现,以模拟翻页。翻页操作实际上是JS向后台发送请求。在这里,它必须请求具有跳转目标页码的背景,然后获取新数据并重新呈现HTML的表部分。这种方法效率更高,但难度更大。因为如果您可以模拟请求,这意味着您已经知道其他人的服务器接口。然后,您可以通过进一步分析响应得到结果。你甚至不需要分析HTML代码,是吗?第二个相对简单的方法,也是我在这里使用的方法,是模拟单击web页面中的“下一页”按钮,然后重新读取HTML代码进行解析

二、ideas

如前所述,此处处理该想法:

在这里,打开和阅读网页的HTML代码是通过selenium实现的

解析HTML代码是通过Beauty soup实现的

三、implementation1.相关库的准备和安装

我使用Mac,因此我可以使用easy Direct_uuInstall命令行安装

1

sudo easy_install beautifulsoup4

或简易安装命令

1

sudo easy_install selenium

在这里,selenium版本已经到达3.0.2,如果要使用此版本的selenium打开网页,则需要使用相应的驱动程序。所以我需要安装一个驱动程序

我在这里使用自制安装的chromediver。安装后,请记住查找chromediver的安装目录。我们将在编写下面的代码时使用它

1

brew install chromedirver

注意:Mac下有许多软件管理包。除了我的安装方法,你可以用pip安装它们,或者直接从官方网站下载安装程序。但您必须安装上述三个程序。在这里我突然有了一个想法。老实说,如果Python拥有与gradle相同的构建管理工具,我现在花在安装这些依赖库上的时间比写代码要多

2.分析页面

只需发布我想要爬升的网页的HTML代码的一部分,在其中我使用//写一些评论:

12345678910111213141516171819202122232425262728293031323334353637383940414243444546474849505152

// 本周排行榜,这是我要抓的内容 排名 明星 鲜花数 TOP粉丝 1 // 这个td标签,star-name的css class是我要抓的内容 王俊凯 1790892 送花 1183*****630 2185*****759 3wx526298988 ...此处省略巨量代码... // 这里是本周排行榜分页的html代码,可以看到一页20个明星,共有50页 首页 尾页// 下面开始就是“上周排行榜”,html结构和上面完全类似...此处再次省略巨量代码...

3.完整代码

1234567891011121314151617181920212223242526272829303132333435

import sysimport urllib2import timefrom bs4 import BeautifulSoupfrom selenium import webdriverreload(sys)sys.setdefaultencoding('utf8') # 设置编码url = 'http://baike.baidu.com/starrank?fr=lemmaxianhua'driver = webdriver.Chrome('/usr/local/Cellar/chromedriver/2.20/bin/chromedriver') # 创建一个driver用于打开网页,记得找到brew安装的chromedriver的位置,在创建driver的时候指定这个位置driver.get(url) # 打开网页name_counter = 1page = 0;while page < 50: # 共50页,这里是手工指定的 soup = BeautifulSoup(driver.page_source, "html.parser") current_names = soup.select('div.ranking-table') # 选择器用ranking-table css class,可以取出包含本周、上周的两个table的div标签 for current_name_list in current_names: # print current_name_list['data-cat'] if current_name_list['data-cat'] == 'thisWeek': # 这次我只想抓取本周,如果想抓上周,改一下这里为lastWeek即可 names = current_name_list.select('td.star-name > a') # beautifulsoup选择器语法 counter = 0; for star_name in names: counter = counter + 1; print star_name.text # 明星的名字是a标签里面的文本,虽然a标签下面除了文本还有一个与文本同级别的img标签,但是.text输出的只是文本而已 name_counter = name_counter + 1; driver.find_element_by_xpath("//a[contains(text(),'下一页')]").click() # selenium的xpath用法,找到包含“下一页”的a标签去点击 page = page + 1 time.sleep(2) # 睡2秒让网页加载完再去读它的html代码print name_counter # 共爬取得明星的名字数量driver.quit()

四、总结

这里只简单记录了一个稍微复杂一点的网页爬行的实现思想。硒和beatifulsoup有很多用法,我没有仔细阅读。这里有一些参考资料。将来有机会我会学到更多

抓取动态网页(如何从javascript页面爬取信息中进行数据爬取?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 99 次浏览 • 2021-09-17 21:00

一、simple动态页面爬行

我们以前的页面爬行工作是基于静态页面的。但是现在很多页面使用动态页面,其中70%的动态页面是由JavaScript编写的。因此,了解如何从JavaScript页面抓取信息对我们来说非常重要

在了解具体情况之前,我们需要了解AJAX是什么。它的英文全称是AsynchronousJavaScript和XML,它是一种异步JavaScript和XML。我们可以通过Ajax请求页面数据,返回的数据格式是JSON类型

然后我们可以根据页面的Ajax格式抓取数据。下面是一个简单的页面爬网

import json

from Chapter3 import download

import csv

def simpletest():

'''

it will write the date to the country.csv

the json data has the attribute records, and the records has area, country and capital value

:return:

'''

fileds = ('area', 'country', 'capital')

writer = csv.writer(open("country.csv", "w"))

writer.writerow(fileds)

d = download.Downloader()

html = d("http://example.webscraping.com ... 6quot;)

try:

ajax = json.loads(html)

except Exception as e:

print str(e)

else:

for record in ajax['records']:

row = [record[filed] for filed in fileds]

writer.writerow(row)

if __name__ == "__main__":

simpletest()

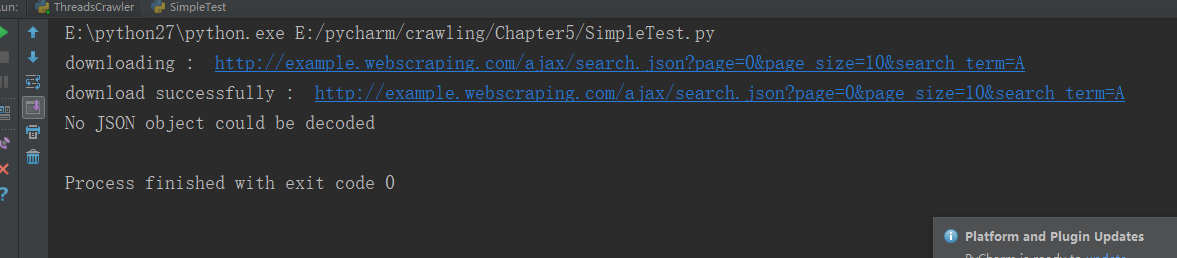

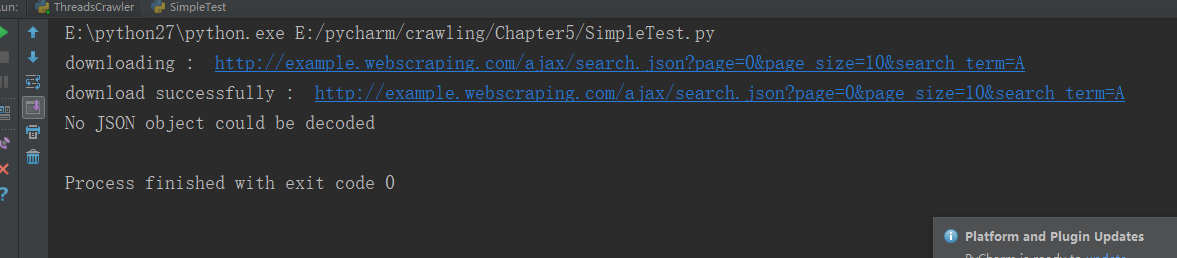

我不知道这是否是问题所在。现在我无法从上述网站下载数据。执行上述程序。以下是结果图:

二、呈现动态页面

在开始之前,首先下载pyside并直接使用PIP install pyside命令行

然后我们可以使用pyside来抓取数据

from PySide.QtWebKit import *

from PySide.QtGui import *

from PySide.QtCore import *

import lxml.html

def simpletest():

'''

get content of the div # result in http://example.webscraping.com ... namic

:return: content

'''

app = QApplication([])

webview = QWebView()

loop = QEventLoop()

# finish the loop if we have finished load the html

webview.loadFinished.connect(loop.quit)

webview.load(QUrl("http://example.webscraping.com ... 6quot;))

loop.exec_()

htmled = webview.page().mainFrame().toHtml()

# get the special content

tree = lxml.html.fromstring(htmled)

return tree.cssselect('#result')[0].text_content()

content = simpletest()

print content

我们回顾了简单动态页面爬行的内容。以前的方法不成功。我认为主要原因是我的网站写得不正确,所以在学习pyside之后,我们可以使用这种新方法进行数据爬行。以下是具体代码:

def getallcountry():

'''

open the html and set search term = a and page_size = 10

and then click auto by javascript

:return:

'''

app = QApplication([])

webview = QWebView()

loop = QEventLoop()

# finish the loop if we have finished load the html

webview.loadFinished.connect(loop.quit)

webview.load(QUrl("http://example.webscraping.com ... 6quot;))

loop.exec_()

# show the webview

webview.show()

frame = webview.page().mainFrame()

# set search text is b

frame.findFirstElement('#search_term').setAttribute('value', 'b')

# set page_size is 10

frame.findFirstElement('#page_size option:checked').setPlainText('10')

# click search button auto

frame.findFirstElement('#search').evaluateJavaScript('this.click()')

app.exec_()

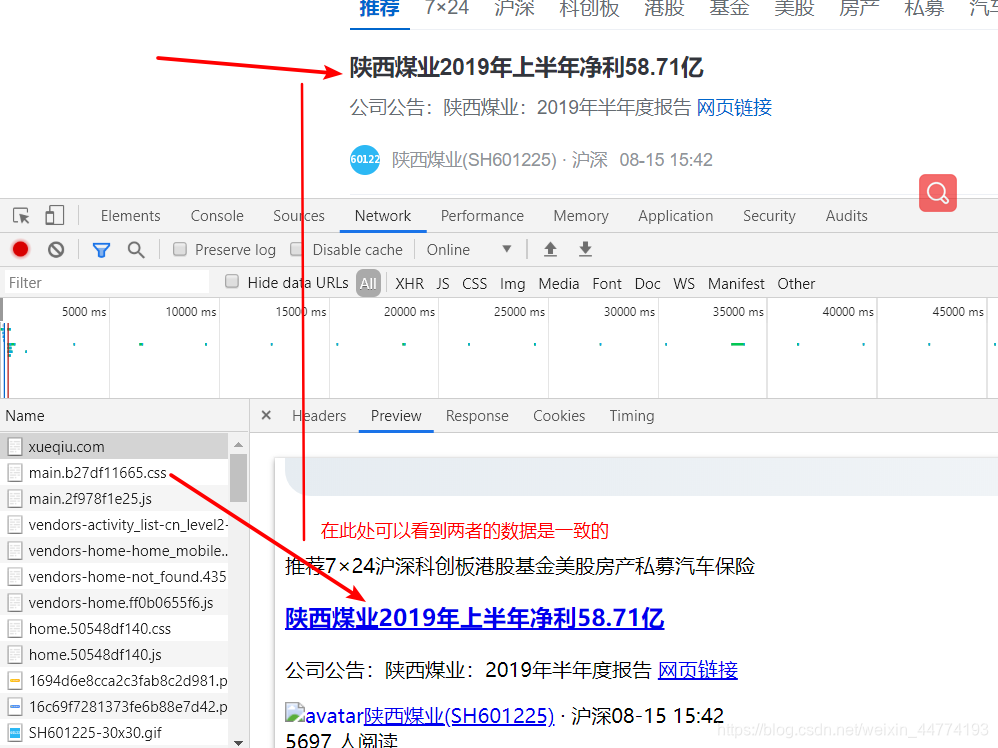

以下是结果图:

在上面的过程中,我们只使用pyside在页面上获取结果,但还没有对数据进行爬网。因为Ajax在响应事件时有一定的延迟,所以有三种方法可以抓取数据:

1、等待一定时间(效率低下)

2、rewrite QT的网络管理器,以跟踪URL请求的完成时间(不适用于客户端问题的情况)

3、轮询页面并等待特定内容出现(检查时浪费CPU时间)

一般来说,第三种方法更可靠、更方便。下面是它的概念代码:它的主要思想是while循环。如果找不到元素,请继续尝试

为了使上述方法更通用,我们可以将它们编写在一个类中。此类收录以下功能:下载、获取HTML、查找对应元素、设置属性值、设置文本值、单击、轮询页面并等待下载

<p>from PySide.QtCore import *

from PySide.QtGui import *

from PySide.QtWebKit import *

import time

import sys

class BrowserRender(QWebView):

def __init__(self, show=True):

'''

if the show is true then we can see webview

:param show:

'''

self.app = QApplication(sys.argv)

QWebView.__init__(self)

if show:

self.show()

def download(self, url, timeout=60):

'''

download the url if timeout is false

:param url: the download url

:param timeout: the timeout time

:return: html if not timeout

'''

loop = QEventLoop()

timer = QTimer()

timer.setSingleShot(True)

timer.timeout.connect(loop.quit)

self.loadFinished.connect(loop.quit)

self.load(QUrl(url))

timer.start(timeout*1000)

loop.exec_()

if timer.isActive():

timer.stop()

return self.html()

else:

print "Request time out "+url

def html(self):

'''

shortcut to return the current html

:return:

'''

return self.page().mainFrame().toHtml()

def find(self, pattern):

'''

find all elements that match the pattern

:param pattern:

:return:

'''

return self.page().mainFrame().findAllElements(pattern)

def attr(self, pattern, name, value):

'''

set attribute for matching pattern

:param pattern:

:param name:

:param value:

:return:

'''

for e in self.find(pattern):

e.setAttribute(name, value)

def text(self, pattern, value):

'''

set plaintext for matching pattern

:param pattern:

:param value:

:return:

'''

for e in self.find(pattern):

e.setPlainText(value)

def click(self, pattern):

'''

click matching pattern

:param pattern:

:return:

'''

for e in self.find(pattern):

e.evaluateJavaScript("this.click()")

def wait_load(self, pattern, timeout=60):

'''

wait untill pattern is found and return matches

:param pattern:

:param timeout:

:return:

'''

deadtiem = time.time() + timeout

while time.time() 查看全部

抓取动态网页(如何从javascript页面爬取信息中进行数据爬取?(一))

一、simple动态页面爬行

我们以前的页面爬行工作是基于静态页面的。但是现在很多页面使用动态页面,其中70%的动态页面是由JavaScript编写的。因此,了解如何从JavaScript页面抓取信息对我们来说非常重要

在了解具体情况之前,我们需要了解AJAX是什么。它的英文全称是AsynchronousJavaScript和XML,它是一种异步JavaScript和XML。我们可以通过Ajax请求页面数据,返回的数据格式是JSON类型

然后我们可以根据页面的Ajax格式抓取数据。下面是一个简单的页面爬网

import json

from Chapter3 import download

import csv

def simpletest():

'''

it will write the date to the country.csv

the json data has the attribute records, and the records has area, country and capital value

:return:

'''

fileds = ('area', 'country', 'capital')

writer = csv.writer(open("country.csv", "w"))

writer.writerow(fileds)

d = download.Downloader()

html = d("http://example.webscraping.com ... 6quot;)

try:

ajax = json.loads(html)

except Exception as e:

print str(e)

else:

for record in ajax['records']:

row = [record[filed] for filed in fileds]

writer.writerow(row)

if __name__ == "__main__":

simpletest()

我不知道这是否是问题所在。现在我无法从上述网站下载数据。执行上述程序。以下是结果图:

二、呈现动态页面

在开始之前,首先下载pyside并直接使用PIP install pyside命令行

然后我们可以使用pyside来抓取数据

from PySide.QtWebKit import *

from PySide.QtGui import *

from PySide.QtCore import *

import lxml.html

def simpletest():

'''

get content of the div # result in http://example.webscraping.com ... namic

:return: content

'''

app = QApplication([])

webview = QWebView()

loop = QEventLoop()

# finish the loop if we have finished load the html

webview.loadFinished.connect(loop.quit)

webview.load(QUrl("http://example.webscraping.com ... 6quot;))

loop.exec_()

htmled = webview.page().mainFrame().toHtml()

# get the special content

tree = lxml.html.fromstring(htmled)

return tree.cssselect('#result')[0].text_content()

content = simpletest()

print content

我们回顾了简单动态页面爬行的内容。以前的方法不成功。我认为主要原因是我的网站写得不正确,所以在学习pyside之后,我们可以使用这种新方法进行数据爬行。以下是具体代码:

def getallcountry():

'''

open the html and set search term = a and page_size = 10

and then click auto by javascript

:return:

'''

app = QApplication([])

webview = QWebView()

loop = QEventLoop()

# finish the loop if we have finished load the html

webview.loadFinished.connect(loop.quit)

webview.load(QUrl("http://example.webscraping.com ... 6quot;))

loop.exec_()

# show the webview

webview.show()

frame = webview.page().mainFrame()

# set search text is b

frame.findFirstElement('#search_term').setAttribute('value', 'b')

# set page_size is 10

frame.findFirstElement('#page_size option:checked').setPlainText('10')

# click search button auto

frame.findFirstElement('#search').evaluateJavaScript('this.click()')

app.exec_()

以下是结果图:

在上面的过程中,我们只使用pyside在页面上获取结果,但还没有对数据进行爬网。因为Ajax在响应事件时有一定的延迟,所以有三种方法可以抓取数据:

1、等待一定时间(效率低下)

2、rewrite QT的网络管理器,以跟踪URL请求的完成时间(不适用于客户端问题的情况)

3、轮询页面并等待特定内容出现(检查时浪费CPU时间)

一般来说,第三种方法更可靠、更方便。下面是它的概念代码:它的主要思想是while循环。如果找不到元素,请继续尝试

为了使上述方法更通用,我们可以将它们编写在一个类中。此类收录以下功能:下载、获取HTML、查找对应元素、设置属性值、设置文本值、单击、轮询页面并等待下载

<p>from PySide.QtCore import *

from PySide.QtGui import *

from PySide.QtWebKit import *

import time

import sys

class BrowserRender(QWebView):

def __init__(self, show=True):

'''

if the show is true then we can see webview

:param show:

'''

self.app = QApplication(sys.argv)

QWebView.__init__(self)

if show:

self.show()

def download(self, url, timeout=60):

'''

download the url if timeout is false

:param url: the download url

:param timeout: the timeout time

:return: html if not timeout

'''

loop = QEventLoop()

timer = QTimer()

timer.setSingleShot(True)

timer.timeout.connect(loop.quit)

self.loadFinished.connect(loop.quit)

self.load(QUrl(url))

timer.start(timeout*1000)

loop.exec_()

if timer.isActive():

timer.stop()

return self.html()

else:

print "Request time out "+url

def html(self):

'''

shortcut to return the current html

:return:

'''

return self.page().mainFrame().toHtml()

def find(self, pattern):

'''

find all elements that match the pattern

:param pattern:

:return:

'''

return self.page().mainFrame().findAllElements(pattern)