怎样抓取网页数据

怎样抓取网页数据(百度抓取器会和网站首页的交互设计)

网站优化 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-10-15 21:16

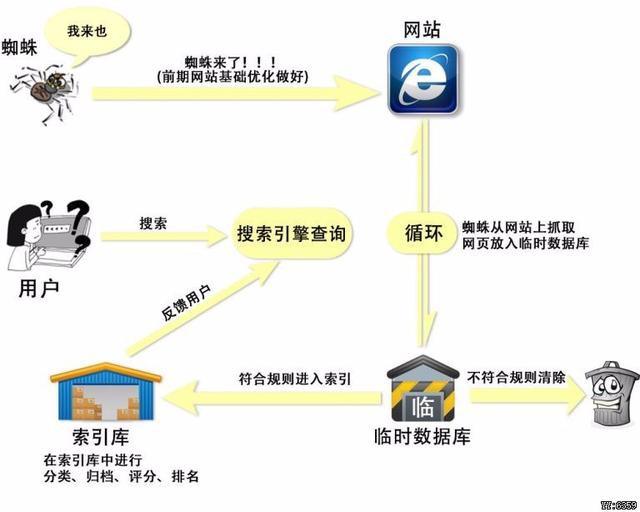

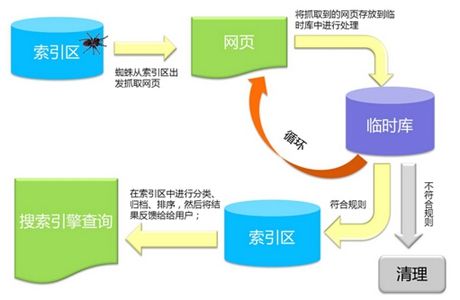

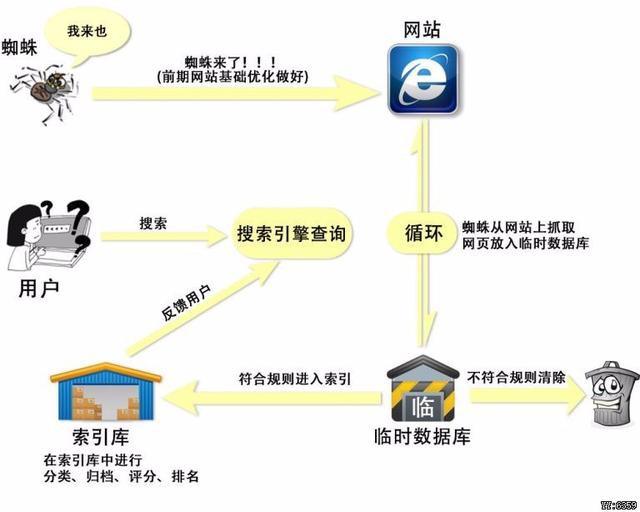

首先,百度的爬虫会与网站的首页进行交互。拿到网站的主页后,会理解页面,理解收录(类型,值计算),其次,网站把主页上的所有超链接都提取出来。

如上图所示,首页上的超链接称为“post-links”。下一轮爬虫的时候,爬虫会继续和这些超链接的页面进行交互,得到页面进行细化,一层一层的继续下去。抓取一层,构成一个抓取循环。

一、爬取友好优化1、URL规范

任何资源都是通过 URL 获取的。URL是相对于网站的门牌号,所以URL规划很重要。尤其是在如上图所示的“待抓取网址”环境中,爬虫在首页的时候,并不知道网址长什么样子。

优秀网址的特点是主流、简单,你可能不想做出一些让人看起来直观的非主流风格。

优秀 URL 示例:

如上图,第一个是百度知道的链接。整个链接分为三个部分。第一部分是网站的站点,第二部分是资源类型,第三部分是资源ID。这种网址很简单,爬虫看起来很不错。

如上图,第三篇文章比百度多了一段。首先,第一段是网站的站点,第二段是站点的一级目录,第三段是站点的二级目录,最后一段是内容ID的网站。像这样的 URL 也符合标准。

不友好 URL 的示例:

如上图所示,这种链接乍一看很长很复杂。有经验的站长可以看到,这种URL收录字符,而这个URL收录文章的标题,导致URL很长。相对较长的 URL 并不优于简单的 URL。百度站长平台规则明确规定网址不能超过256字节。我个人建议 URL 长度控制在 100 字节和 100 个字符以内。足以显示资源的 URL。

如上图所示,该网址收录统计参数,可能导致重复爬取,浪费站点权限。因此,可能不使用参数。如果必须使用参数,也可以保留必要的参数。参数字符可以使用常规字符。连接器,例如“?” 和“&”,避免非主流连接器。

2、 合理发现链接

爬虫从首页一层一层的爬取,所以需要搞好首页和资源页的URL关系。这种爬虫爬行比较省力。

如上图所示,从首页到具体内容的超链接路径关系称为发现链接。目前大部分移动站不太重视发现链接关系,因此爬虫无法抓取到内容页面。

如上图所示,这两个站点是常见的移动网站构建方式。从链接发现的角度来看,这两类网站并不友好。

馈送流建议:

大多数进行流式传输的网站在后台都有大量数据。用户不断刷新时会出现新的内容,但无论刷新多少次,可能只能刷新到1%左右的内容,而爬虫等价于一个用户不可能爬取全部内容网站 这种方式,所以有些页面不会被抓取。即使您有 100 万个内容,您也可能只能对其进行抓取。1-2百万。

仅搜索条目:

如上图所示,首页只有一个搜索框。用户需要输入关键词才能找到对应的内容,但是爬虫不能输入关键词再爬,所以爬虫只能爬到首页后,没有反向链接,而且自然爬行和 收录 会不令人满意。

解决方案:

索引页下的内容按出版时间倒序排列。这样做的好处是搜索引擎甚至可以通过索引页抓取你的网站最新资源,并且新发布的资源应该在索引页中实时同步。,很多纯静态网页,内容更新了,但是首页(索引页)不出来。这会导致搜索引擎甚至无法通过索引页面抓取最新的资源。第三点是后链(latest文章的URL)需要在源码中直接暴露出来,方便搜索引擎抓取。最后,索引页不要越多越好。几个高质量的索引页就够了,比如长城,基本上只用首页来做。索引页。

最后,这里给大家一个更高效的解决方案,就是直接通过百度站长资源平台主动提交资源,让搜索引擎绕过索引页,直接抓取最新的资源。这里有两点需要注意。

Q:提交更多资源更好吗?

A:收录 效果的核心永远是内容的质量。如果大量低质量、泛滥的资源被提交,将导致惩罚性打击。

Q:为什么我提交了普通的收录却没有被抓到?

A:资源提交只能加速资源发现,不能保证短期抓取。当然,百度表示不断优化算法,让优质内容更快被抓取。

3、访问友好

抓取器必须与网站进行交互并保证网站的稳定性,这样抓取器才能正常抓取。那么访问友好性主要包括以下几个方面。

访问速度优化:

加载时间建议控制在2S以内,所以无论是用户还是爬虫,打开速度更快的网站会更受青睐,避免不必要的跳转。这种情况虽然是一小部分,但是在网站中还是有很多层次的跳转,所以对于爬虫来说,很有可能会在多层次跳转的同时断开。一般是把不带www的域名重定向到带WWW的域名,然后带WWW的域名需要重定向到https,最后更换新站。在这种情况下,将有三个或四个级别的重定向。如果有类似网站的修改,建议直接跳转到新域名。 查看全部

怎样抓取网页数据(百度抓取器会和网站首页的交互设计)

首先,百度的爬虫会与网站的首页进行交互。拿到网站的主页后,会理解页面,理解收录(类型,值计算),其次,网站把主页上的所有超链接都提取出来。

如上图所示,首页上的超链接称为“post-links”。下一轮爬虫的时候,爬虫会继续和这些超链接的页面进行交互,得到页面进行细化,一层一层的继续下去。抓取一层,构成一个抓取循环。

一、爬取友好优化1、URL规范

任何资源都是通过 URL 获取的。URL是相对于网站的门牌号,所以URL规划很重要。尤其是在如上图所示的“待抓取网址”环境中,爬虫在首页的时候,并不知道网址长什么样子。

优秀网址的特点是主流、简单,你可能不想做出一些让人看起来直观的非主流风格。

优秀 URL 示例:

如上图,第一个是百度知道的链接。整个链接分为三个部分。第一部分是网站的站点,第二部分是资源类型,第三部分是资源ID。这种网址很简单,爬虫看起来很不错。

如上图,第三篇文章比百度多了一段。首先,第一段是网站的站点,第二段是站点的一级目录,第三段是站点的二级目录,最后一段是内容ID的网站。像这样的 URL 也符合标准。

不友好 URL 的示例:

如上图所示,这种链接乍一看很长很复杂。有经验的站长可以看到,这种URL收录字符,而这个URL收录文章的标题,导致URL很长。相对较长的 URL 并不优于简单的 URL。百度站长平台规则明确规定网址不能超过256字节。我个人建议 URL 长度控制在 100 字节和 100 个字符以内。足以显示资源的 URL。

如上图所示,该网址收录统计参数,可能导致重复爬取,浪费站点权限。因此,可能不使用参数。如果必须使用参数,也可以保留必要的参数。参数字符可以使用常规字符。连接器,例如“?” 和“&”,避免非主流连接器。

2、 合理发现链接

爬虫从首页一层一层的爬取,所以需要搞好首页和资源页的URL关系。这种爬虫爬行比较省力。

如上图所示,从首页到具体内容的超链接路径关系称为发现链接。目前大部分移动站不太重视发现链接关系,因此爬虫无法抓取到内容页面。

如上图所示,这两个站点是常见的移动网站构建方式。从链接发现的角度来看,这两类网站并不友好。

馈送流建议:

大多数进行流式传输的网站在后台都有大量数据。用户不断刷新时会出现新的内容,但无论刷新多少次,可能只能刷新到1%左右的内容,而爬虫等价于一个用户不可能爬取全部内容网站 这种方式,所以有些页面不会被抓取。即使您有 100 万个内容,您也可能只能对其进行抓取。1-2百万。

仅搜索条目:

如上图所示,首页只有一个搜索框。用户需要输入关键词才能找到对应的内容,但是爬虫不能输入关键词再爬,所以爬虫只能爬到首页后,没有反向链接,而且自然爬行和 收录 会不令人满意。

解决方案:

索引页下的内容按出版时间倒序排列。这样做的好处是搜索引擎甚至可以通过索引页抓取你的网站最新资源,并且新发布的资源应该在索引页中实时同步。,很多纯静态网页,内容更新了,但是首页(索引页)不出来。这会导致搜索引擎甚至无法通过索引页面抓取最新的资源。第三点是后链(latest文章的URL)需要在源码中直接暴露出来,方便搜索引擎抓取。最后,索引页不要越多越好。几个高质量的索引页就够了,比如长城,基本上只用首页来做。索引页。

最后,这里给大家一个更高效的解决方案,就是直接通过百度站长资源平台主动提交资源,让搜索引擎绕过索引页,直接抓取最新的资源。这里有两点需要注意。

Q:提交更多资源更好吗?

A:收录 效果的核心永远是内容的质量。如果大量低质量、泛滥的资源被提交,将导致惩罚性打击。

Q:为什么我提交了普通的收录却没有被抓到?

A:资源提交只能加速资源发现,不能保证短期抓取。当然,百度表示不断优化算法,让优质内容更快被抓取。

3、访问友好

抓取器必须与网站进行交互并保证网站的稳定性,这样抓取器才能正常抓取。那么访问友好性主要包括以下几个方面。

访问速度优化:

加载时间建议控制在2S以内,所以无论是用户还是爬虫,打开速度更快的网站会更受青睐,避免不必要的跳转。这种情况虽然是一小部分,但是在网站中还是有很多层次的跳转,所以对于爬虫来说,很有可能会在多层次跳转的同时断开。一般是把不带www的域名重定向到带WWW的域名,然后带WWW的域名需要重定向到https,最后更换新站。在这种情况下,将有三个或四个级别的重定向。如果有类似网站的修改,建议直接跳转到新域名。

怎样抓取网页数据(解析XML网页链接来抓取指定的内容比如豆瓣电影排行榜,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-10-14 08:05

如果给你一个网页链接来抓取特定内容,比如豆瓣电影排名,怎么做?

其实网页内容的结构和XML很像,所以我们可以通过解析XML来解析HTML,但是两者的差距还是很大的,好吧,废话不多说,我们开始解析HTML。

然后有很多用于解析 XML 的库。这里我们选择libxml进行解析。因为libxml是C语言接口,所以找了个library-hpple,用objective-c来封装接口。它的地址是,然后网页使用豆瓣电影排名。地址是。

接下来,构建一个新项目。项目使用ARC,引入libxml2和hpple库,新建实体类movie。完整的项目结构如下:

movie的实现如下,这是一个实体类,根据爬取的网页内容确定

电影.h

@interface Movie : NSObject

@property(nonatomic, strong) NSString *name;

@property(nonatomic, strong) NSString *imageUrl;

@property(nonatomic, strong) NSString *descrition;

@property(nonatomic, strong) NSString *movieUrl;

@property(nonatomic) NSInteger ratingNumber;

@property(nonatomic, strong) NSString *comment;

@end

那么最重要的部分来了,不管网页的内容是什么,我们首先要获取网页的内容,下面是通过NSURLConnection获取整个网页的内容。

- (void)loadHTMLContent

{

NSString *movieUrl = MOVIE_URL;

NSString *urlString = [movieUrl stringByAddingPercentEscapesUsingEncoding:NSUTF8StringEncoding];

NSURL *url = [NSURL URLWithString:urlString];

NSURLRequest *request = [NSURLRequest requestWithURL:url];

[UIApplication sharedApplication].networkActivityIndicatorVisible = YES;

__weak ViewController *weak_self = self;

[NSURLConnection sendAsynchronousRequest:request queue:[NSOperationQueue mainQueue] completionHandler:^(NSURLResponse *response, NSData *data, NSError *error) {

if (nil == error) {

// NSString *retString = [[NSString alloc] initWithData:data encoding:NSUTF8StringEncoding];

// NSLog(@"%@", retString);

[weak_self parserHTML:data];

}

[UIApplication sharedApplication].networkActivityIndicatorVisible = NO;

}];

}

这里只是简单的访问web内容,一些HTTP和错误处理本文没有讨论,所以这里的代码比较简单,上面代码中有一个parserHTML:方法,就是解析获取到的web内容和解析网页内容之前,我们先拆解xpath。

假设一个简单的网页内容如下:

Some webpage

<p class=”normal”>This is the first paragraph

This is the second paragraph. This is in bold.

</p>

比如要获取title的内容,那么xpath表达式就是/html/head/title。如果要获取class="special"节点的内容,xpath为/html/body/p[@class='special']。

所以只要找到合适的xpath,就会得到对应的节点内容,接下来我们看看用hpple解析HTML

- (void)parserHTML:(NSData *)data

{

if (nil != data) {

TFHpple *movieParser = [TFHpple hppleWithHTMLData:data];

NSString *movieXpathQueryString = @"/html/body/div[@id='wrapper']/div[@id='content']/div[@class='grid-16-8 clearfix']/div[@class='article']/div[@class='indent']/table/tr/td/a[@class='nbg']";

NSArray *movieNodes = [movieParser searchWithXPathQuery:movieXpathQueryString];

for (TFHppleElement *element in movieNodes) {

Movie *m = [[Movie alloc] init];

m.name = [element objectForKey:@"title"];

m.movieUrl = [element objectForKey:@"href"];

for (TFHppleElement *child in element.children) {

if ([child.tagName isEqualToString:@"img"]) {

@try {

m.imageUrl = [child objectForKey:@"src"];

}

@catch (NSException *exception) {

}

}

}

[self.movies addObject:m];

}

[self.movieTableView reloadData];

}

}

在代码中找到首页对应节点的路径,然后searchWithXPathQuery得到一个数组,遍历组织数据显示在表格视图中。具体效果如下:

好了,网页的内容已经抓到了,实际的项目比这个复杂,所以,这只是一个指导性的例子。

参考:

注:本文为小涵原创,请支持原创!转载请附上原文链接: 查看全部

怎样抓取网页数据(解析XML网页链接来抓取指定的内容比如豆瓣电影排行榜,)

如果给你一个网页链接来抓取特定内容,比如豆瓣电影排名,怎么做?

其实网页内容的结构和XML很像,所以我们可以通过解析XML来解析HTML,但是两者的差距还是很大的,好吧,废话不多说,我们开始解析HTML。

然后有很多用于解析 XML 的库。这里我们选择libxml进行解析。因为libxml是C语言接口,所以找了个library-hpple,用objective-c来封装接口。它的地址是,然后网页使用豆瓣电影排名。地址是。

接下来,构建一个新项目。项目使用ARC,引入libxml2和hpple库,新建实体类movie。完整的项目结构如下:

movie的实现如下,这是一个实体类,根据爬取的网页内容确定

电影.h

@interface Movie : NSObject

@property(nonatomic, strong) NSString *name;

@property(nonatomic, strong) NSString *imageUrl;

@property(nonatomic, strong) NSString *descrition;

@property(nonatomic, strong) NSString *movieUrl;

@property(nonatomic) NSInteger ratingNumber;

@property(nonatomic, strong) NSString *comment;

@end

那么最重要的部分来了,不管网页的内容是什么,我们首先要获取网页的内容,下面是通过NSURLConnection获取整个网页的内容。

- (void)loadHTMLContent

{

NSString *movieUrl = MOVIE_URL;

NSString *urlString = [movieUrl stringByAddingPercentEscapesUsingEncoding:NSUTF8StringEncoding];

NSURL *url = [NSURL URLWithString:urlString];

NSURLRequest *request = [NSURLRequest requestWithURL:url];

[UIApplication sharedApplication].networkActivityIndicatorVisible = YES;

__weak ViewController *weak_self = self;

[NSURLConnection sendAsynchronousRequest:request queue:[NSOperationQueue mainQueue] completionHandler:^(NSURLResponse *response, NSData *data, NSError *error) {

if (nil == error) {

// NSString *retString = [[NSString alloc] initWithData:data encoding:NSUTF8StringEncoding];

// NSLog(@"%@", retString);

[weak_self parserHTML:data];

}

[UIApplication sharedApplication].networkActivityIndicatorVisible = NO;

}];

}

这里只是简单的访问web内容,一些HTTP和错误处理本文没有讨论,所以这里的代码比较简单,上面代码中有一个parserHTML:方法,就是解析获取到的web内容和解析网页内容之前,我们先拆解xpath。

假设一个简单的网页内容如下:

Some webpage

<p class=”normal”>This is the first paragraph

This is the second paragraph. This is in bold.

</p>

比如要获取title的内容,那么xpath表达式就是/html/head/title。如果要获取class="special"节点的内容,xpath为/html/body/p[@class='special']。

所以只要找到合适的xpath,就会得到对应的节点内容,接下来我们看看用hpple解析HTML

- (void)parserHTML:(NSData *)data

{

if (nil != data) {

TFHpple *movieParser = [TFHpple hppleWithHTMLData:data];

NSString *movieXpathQueryString = @"/html/body/div[@id='wrapper']/div[@id='content']/div[@class='grid-16-8 clearfix']/div[@class='article']/div[@class='indent']/table/tr/td/a[@class='nbg']";

NSArray *movieNodes = [movieParser searchWithXPathQuery:movieXpathQueryString];

for (TFHppleElement *element in movieNodes) {

Movie *m = [[Movie alloc] init];

m.name = [element objectForKey:@"title"];

m.movieUrl = [element objectForKey:@"href"];

for (TFHppleElement *child in element.children) {

if ([child.tagName isEqualToString:@"img"]) {

@try {

m.imageUrl = [child objectForKey:@"src"];

}

@catch (NSException *exception) {

}

}

}

[self.movies addObject:m];

}

[self.movieTableView reloadData];

}

}

在代码中找到首页对应节点的路径,然后searchWithXPathQuery得到一个数组,遍历组织数据显示在表格视图中。具体效果如下:

好了,网页的内容已经抓到了,实际的项目比这个复杂,所以,这只是一个指导性的例子。

参考:

注:本文为小涵原创,请支持原创!转载请附上原文链接:

怎样抓取网页数据(就是使用Excel2013自带的工具--从网页获取数据Excel来分析的话 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-10-12 22:25

)

核心提示:很多时候,一些数据来自网页。如果我们要采集网页数据并用Excel进行分析,是否需要将网页上的数据一一输入Excel?

很多时候,一些数据来自网络。如果我们要采集网页数据并使用Excel进行分析,是否需要将网页上的数据一一输入Excel?其实还有一个很方便的方法,那就是使用Excel 2013自带的工具---从网页获取数据,不仅可以快速获取数据,还可以与网页内容同步更新。下面是详细的操作方法。

1、首先打开Excel,点击菜单栏:数据--来自网站。

2、 你会看到一个打开的查询对话框,你的IE主页会自动打开,在地址栏中输入你想要的URL,然后点击Go。

我们看到打开了一个网页。如果我们要导入这个表中的数据,我们看下面的第二张图,点击左上角的黄色按钮。选择表格后,黄色按钮变为绿色。

3、 然后点击导入按钮,你会看到下面的第二张图片,等待几秒钟。

4、打开一个对话框,提示你把数据放在哪里,点击确定导入数据。

5、 也可以点击属性设置导入,如图。在下图中,如果设置刷新率,您会看到Excel表格中的数据可以基于网页上的数据。更新,是不是很强大。

6、好的,这是我们导入的数据。Excel 2013 现在很强大吗?哈哈,赶紧装个Office 2013,试试它的强大功能吧。

查看全部

怎样抓取网页数据(就是使用Excel2013自带的工具--从网页获取数据Excel来分析的话

)

核心提示:很多时候,一些数据来自网页。如果我们要采集网页数据并用Excel进行分析,是否需要将网页上的数据一一输入Excel?

很多时候,一些数据来自网络。如果我们要采集网页数据并使用Excel进行分析,是否需要将网页上的数据一一输入Excel?其实还有一个很方便的方法,那就是使用Excel 2013自带的工具---从网页获取数据,不仅可以快速获取数据,还可以与网页内容同步更新。下面是详细的操作方法。

1、首先打开Excel,点击菜单栏:数据--来自网站。

2、 你会看到一个打开的查询对话框,你的IE主页会自动打开,在地址栏中输入你想要的URL,然后点击Go。

我们看到打开了一个网页。如果我们要导入这个表中的数据,我们看下面的第二张图,点击左上角的黄色按钮。选择表格后,黄色按钮变为绿色。

3、 然后点击导入按钮,你会看到下面的第二张图片,等待几秒钟。

4、打开一个对话框,提示你把数据放在哪里,点击确定导入数据。

5、 也可以点击属性设置导入,如图。在下图中,如果设置刷新率,您会看到Excel表格中的数据可以基于网页上的数据。更新,是不是很强大。

6、好的,这是我们导入的数据。Excel 2013 现在很强大吗?哈哈,赶紧装个Office 2013,试试它的强大功能吧。

怎样抓取网页数据(网络爬虫软件从指定网页获取特定内容的几种解决方案)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2021-10-04 00:19

摘要:对于程序员或开发者来说,拥有编程技能,让他们构建一个网页数据爬取程序变得非常容易和有趣。但是对于大多数没有任何编程知识的人来说,最好使用一些网络爬虫软件从指定的网页中获取特定的内容。

网页数据爬取是指在不请求网站的API接口获取内容的情况下,从网站中提取特定内容。“网页数据”作为网站用户体验的一部分,如网页上的文字、图片、声音、视频、动画等,均被视为网页数据。

对于程序员或开发者来说,拥有编程能力,让他们构建一个网页数据爬取程序变得非常容易和有趣。但是对于大多数没有任何编程知识的人来说,最好使用一些网络爬虫软件从指定的网页中获取特定的内容。下面是一些使用优采云采集器抓取网页数据的解决方案:

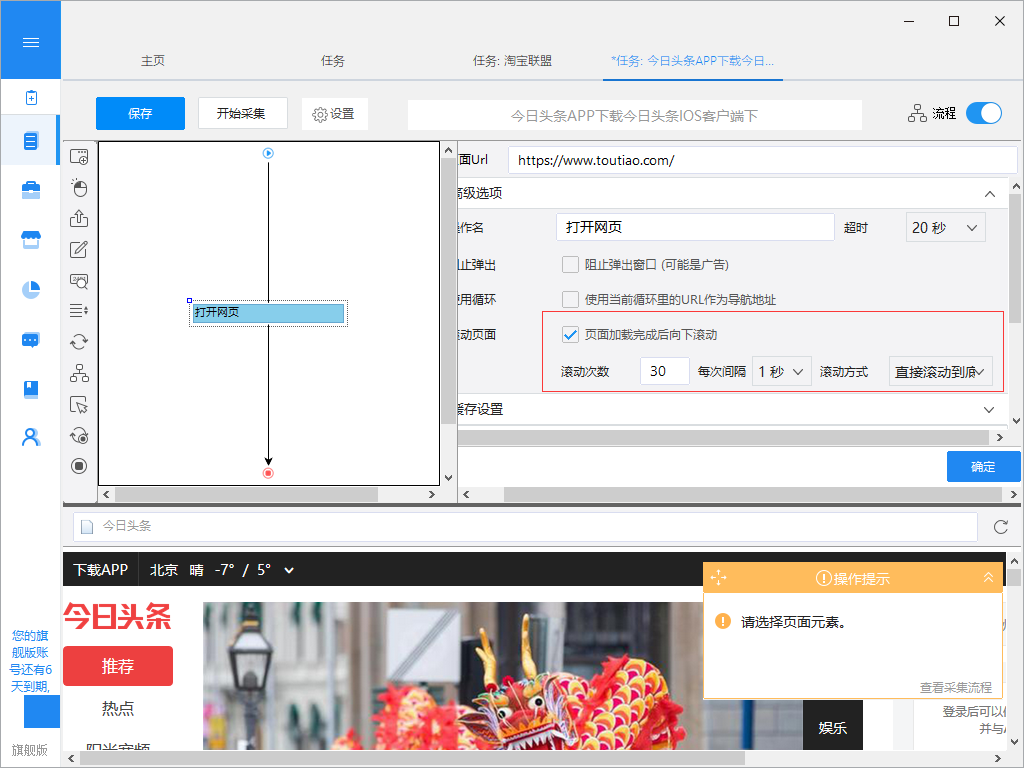

1、从动态网页中提取内容

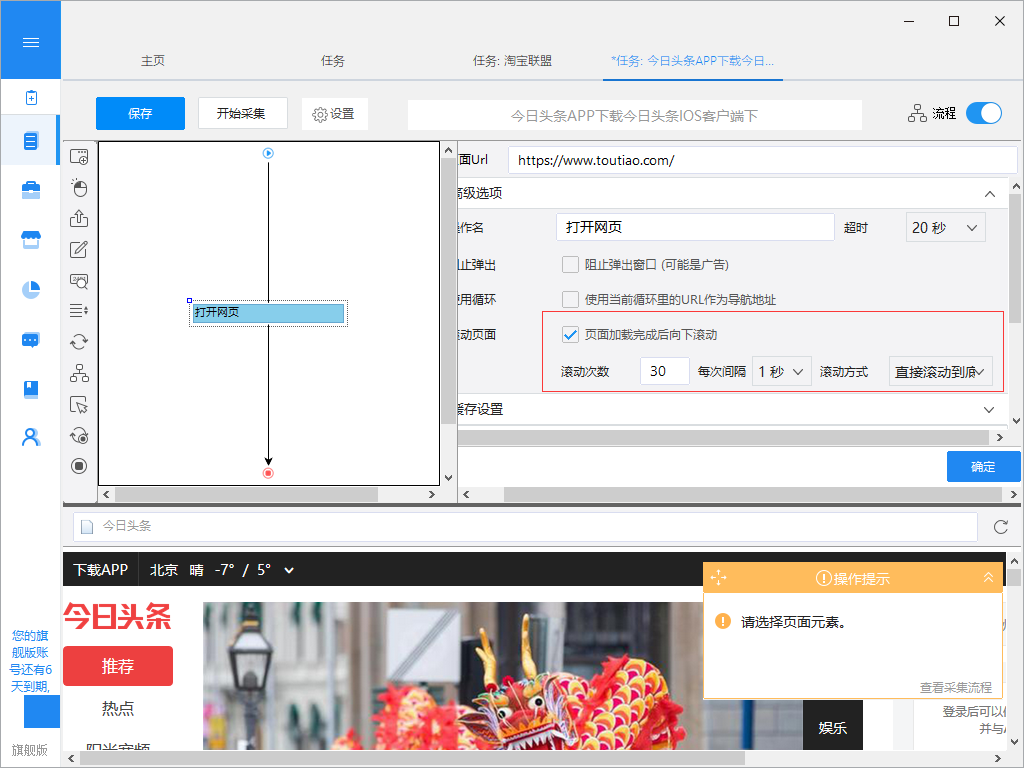

网页可以是静态的或动态的。通常情况下,您要提取的网页内容会随着您访问网站的时间而变化。通常,这个网站是一个动态的网站,它使用AJAX技术或其他技术使网页内容能够及时更新。AJAX 是一种延迟加载和异步更新的脚本技术。通过后台与服务器的少量数据交换,可以在不重新加载整个网页的情况下更新网页的某一部分。

性能特点是当你点击网页中的一个选项时,网站的大部分URL都不会改变;网页未完全加载,但仅部分加载了数据并发生了更改。这时候可以在优采云的“高级选项”元素的“Ajax加载”中设置,然后就可以抓取Ajax加载的网页数据了。

2、 从网页中抓取隐藏内容

你有没有想过从网站获取具体的数据,但是当你触发链接或者将鼠标悬停在某处时,内容就会出现?比如下图中的网站,需要将鼠标移动到选中的彩票上才能显示分类。这是设置“鼠标指向此链接”来捕捉网页隐藏内容的功能。.

3、 从无限滚动的网页中提取内容

滚动到页面底部后,某些网站 只会显示您要提取的部分数据。比如今天的头条首页,需要一直滚动到页面底部才能加载更多的文章内容。无限滚动 网站 通常使用 AJAX 或 JavaScript 从 网站 内容请求附加内容。在这种情况下,您可以设置 AJAX 超时设置并选择滚动方式和滚动时间以从网页中提取内容。

4、 从网页中抓取所有链接

一个普通的 网站 将收录至少一个超链接。如果要提取网页中的所有链接,可以使用优采云 获取网页上发布的所有超链接。

5、从网页中抓取所有文本

有时你需要提取一个 HTML 文档中的所有文本,即把它放在 HTML 标签中(如

标签或标签)。优采云 使您能够提取网页源代码中的所有或特定文本。

6、 从网页中抓取所有图片

有的朋友对采集网页图片有需求。优采云可以下载网页中图片的网址采集,然后下载使用优采云专用的图片批量下载工具,即可上传图片中的图片我们采集 下载并保存到本地计算机的 URL。 查看全部

怎样抓取网页数据(网络爬虫软件从指定网页获取特定内容的几种解决方案)

摘要:对于程序员或开发者来说,拥有编程技能,让他们构建一个网页数据爬取程序变得非常容易和有趣。但是对于大多数没有任何编程知识的人来说,最好使用一些网络爬虫软件从指定的网页中获取特定的内容。

网页数据爬取是指在不请求网站的API接口获取内容的情况下,从网站中提取特定内容。“网页数据”作为网站用户体验的一部分,如网页上的文字、图片、声音、视频、动画等,均被视为网页数据。

对于程序员或开发者来说,拥有编程能力,让他们构建一个网页数据爬取程序变得非常容易和有趣。但是对于大多数没有任何编程知识的人来说,最好使用一些网络爬虫软件从指定的网页中获取特定的内容。下面是一些使用优采云采集器抓取网页数据的解决方案:

1、从动态网页中提取内容

网页可以是静态的或动态的。通常情况下,您要提取的网页内容会随着您访问网站的时间而变化。通常,这个网站是一个动态的网站,它使用AJAX技术或其他技术使网页内容能够及时更新。AJAX 是一种延迟加载和异步更新的脚本技术。通过后台与服务器的少量数据交换,可以在不重新加载整个网页的情况下更新网页的某一部分。

性能特点是当你点击网页中的一个选项时,网站的大部分URL都不会改变;网页未完全加载,但仅部分加载了数据并发生了更改。这时候可以在优采云的“高级选项”元素的“Ajax加载”中设置,然后就可以抓取Ajax加载的网页数据了。

2、 从网页中抓取隐藏内容

你有没有想过从网站获取具体的数据,但是当你触发链接或者将鼠标悬停在某处时,内容就会出现?比如下图中的网站,需要将鼠标移动到选中的彩票上才能显示分类。这是设置“鼠标指向此链接”来捕捉网页隐藏内容的功能。.

3、 从无限滚动的网页中提取内容

滚动到页面底部后,某些网站 只会显示您要提取的部分数据。比如今天的头条首页,需要一直滚动到页面底部才能加载更多的文章内容。无限滚动 网站 通常使用 AJAX 或 JavaScript 从 网站 内容请求附加内容。在这种情况下,您可以设置 AJAX 超时设置并选择滚动方式和滚动时间以从网页中提取内容。

4、 从网页中抓取所有链接

一个普通的 网站 将收录至少一个超链接。如果要提取网页中的所有链接,可以使用优采云 获取网页上发布的所有超链接。

5、从网页中抓取所有文本

有时你需要提取一个 HTML 文档中的所有文本,即把它放在 HTML 标签中(如

标签或标签)。优采云 使您能够提取网页源代码中的所有或特定文本。

6、 从网页中抓取所有图片

有的朋友对采集网页图片有需求。优采云可以下载网页中图片的网址采集,然后下载使用优采云专用的图片批量下载工具,即可上传图片中的图片我们采集 下载并保存到本地计算机的 URL。

怎样抓取网页数据(中华英才网数据自动聚合系统正是由此而生|案例分析案例)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-10-02 16:23

1.简介

项目背景

互联网时代,信息海阔天空。甚至我们获取信息的方式也发生了变化:从传统的翻书到查字典,再到通过搜索引擎搜索。我们已经从信息匮乏的时代走到了信息丰富的今天。

今天,困扰我们的问题不是信息太少,而是太多,太多让你无法分辨或选择。因此,提供一种能够自动抓取互联网上的数据,并对其进行自动排序和分析的工具是非常重要的。

我们通过传统搜索引擎获取的信息通常以网页的形式展示。这样的信息手动阅读自然友好,但计算机很难处理和重复使用。而且检索到的信息量太大,我们很难从海量的检索结果中提取出我们最需要的信息。

本方案所涉及的数据聚合系统由此诞生。系统按照一定的规则抓取指定的网站中的信息,对抓取的结果进行分析整理,保存在结构化的数据库中,为数据的复用做准备。

中华英才网是知名的大型招聘类网站。为了全面细致地了解招聘市场的整体能力,帮助中华英才网全面了解其他竞争对手的情况,为市场人员提供潜在客户信息,我们提供此解决方案。

使命和宗旨

捷软与中华英才网合作开发数据自动聚合系统,从互联网上获取公开的信息资源,对信息进行分析、处理和再加工,为中华英才网营销部门提供准确的市场信息资源。

2.方案设计原则

我们在设计系统方案时充分考虑了以下两个原则,并将始终贯穿于设计和开发过程:

系统精度

系统需要从互联网庞大的信息海洋中获取信息。如何保证它抓取的信息的准确性和有效性,是评估整个系统价值的关键因素。因此,除了对抓取到的信息进行整理分析,当目标网站的内容和格式发生变化时,智能感知和及时通知调整也是保证系统准确性的重要手段。.

系统灵活性

该系统虽然是为少数用户提供服务并监控固定站点的内部系统,但仍需具备一定的灵活性和较强的可扩展性。

因为目标站点的结构、层次和格式在不断变化;并且系统需要抓取的目标站点也在不断调整;因此,系统必须能够适应这种变化。当爬取目标发生变化时,系统可以通过简单的设置或调整,继续完成数据聚合任务。

3.解决方案:

1.功能结构图

2.定义格式并准备脚本

首先,我们需要根据需要爬取的目标网站的特点,编写一个爬取脚本(格式)。包括:

目标网站的URL路径;

使用什么方法获取数据?可以使用模拟查询功能的方法(手动检测查询页面提交的参数并模拟提交);也可以从头到尾遍历序列号(需要找到当前最大的序列号值);

根据每个网站的特点编译(标准、脚本);

3.获取数据

系统提供的rake程序会根据预定义的XML格式执行数据采集任务。为了防止目标网站的检测程序发现它,我们建议在处理之前直接保存捕获的页面。而不是在获得信息后立即进行处理,对于提高抓取和保留第一手信息的效率非常有价值。

通过定义的脚本模拟登录;

对于下拉列表中的查询项,循环遍历列表中的每个值。并对获取查询结果的页面进行模拟翻页操作,获取所有查询结果;

如果作业数据库或业务目录数据库使用自增整数作为其唯一ID,那么我们可以想办法获取最大值,然后通过遍历的方法将其全部抓取;

定时执行爬取操作,增量保存抓取到的数据;

4.简单分析

采集接收到的数据在外网的服务器上简单的分析处理。内容主要包括:

结构化数据:对获取的数据进行结构化,以方便以后的数据传输,也方便下一步的复查和故障排除任务。

消除重复;使用模拟查询方法遍历时,系统捕获的数据必须是重复的。由于重复的数据会造成重复的分析和处理过程,不仅占用系统资源,使系统的处理效率低下,而且给系统带来了大量的垃圾数据。为了避免大量重复和冗余的数据,我们要做的第一个处理工作就是对重复项进行整理。

消除错误;由于目标站点的内容、结构和格式的调整,系统将无法捕获或捕获大量错误信息。在排除这些误报信息的同时,我们通过数据错误率的判断,可以获得目标站点是否发生变化的信息,并及时向系统发出预警通知。

5.数据发回内部

系统通过Web Service将处理后的数据发送回企业。唯一需要考虑的是如何实现增量更新,否则每天有大量数据更新到本地数据库,会造成网络拥塞。

6.数据分析

这里的数据分析与上述在远程服务器上进行的分析操作不同。后者是为了简单有效的数据过滤,防止数据冗余和造成处理速度缓慢或网络拥塞。前者为日后人工确认提供便利,有效帮助市场人员进行快速人工分拣。详情如下:

l 按地区区分;

l 按准确程度划分;帮助用户优先考虑哪些信息更有效;

l 按发帖数划分;

l 记录各公司发布的职位变动过程;

7.手动确认

这部分主要关注两个方面:

1、提供友好的人机界面,用于手动确认这些信息;

2、对比英才网的职位数据库,提取差异进行人工确认:

通过与市场人员的沟通交流,了解他们关心的信息,按照他们期望的方式提供数据,完成人工确认。

8.统计汇总

汇总统计功能也是数据汇总系统的重要组成部分,将提供以下几类统计汇总功能:

以网站为单位,统计每个网站日新增的公司、职位等信息;

跟踪大型企业,统计其在每个网站上发布的信息帖记录;

以时间为单位,按日、周、月对各种信息进行统计;

按地区、公司、岗位进行统计;

其他;

仿真统计汇总界面

[引用] 查看全部

怎样抓取网页数据(中华英才网数据自动聚合系统正是由此而生|案例分析案例)

1.简介

项目背景

互联网时代,信息海阔天空。甚至我们获取信息的方式也发生了变化:从传统的翻书到查字典,再到通过搜索引擎搜索。我们已经从信息匮乏的时代走到了信息丰富的今天。

今天,困扰我们的问题不是信息太少,而是太多,太多让你无法分辨或选择。因此,提供一种能够自动抓取互联网上的数据,并对其进行自动排序和分析的工具是非常重要的。

我们通过传统搜索引擎获取的信息通常以网页的形式展示。这样的信息手动阅读自然友好,但计算机很难处理和重复使用。而且检索到的信息量太大,我们很难从海量的检索结果中提取出我们最需要的信息。

本方案所涉及的数据聚合系统由此诞生。系统按照一定的规则抓取指定的网站中的信息,对抓取的结果进行分析整理,保存在结构化的数据库中,为数据的复用做准备。

中华英才网是知名的大型招聘类网站。为了全面细致地了解招聘市场的整体能力,帮助中华英才网全面了解其他竞争对手的情况,为市场人员提供潜在客户信息,我们提供此解决方案。

使命和宗旨

捷软与中华英才网合作开发数据自动聚合系统,从互联网上获取公开的信息资源,对信息进行分析、处理和再加工,为中华英才网营销部门提供准确的市场信息资源。

2.方案设计原则

我们在设计系统方案时充分考虑了以下两个原则,并将始终贯穿于设计和开发过程:

系统精度

系统需要从互联网庞大的信息海洋中获取信息。如何保证它抓取的信息的准确性和有效性,是评估整个系统价值的关键因素。因此,除了对抓取到的信息进行整理分析,当目标网站的内容和格式发生变化时,智能感知和及时通知调整也是保证系统准确性的重要手段。.

系统灵活性

该系统虽然是为少数用户提供服务并监控固定站点的内部系统,但仍需具备一定的灵活性和较强的可扩展性。

因为目标站点的结构、层次和格式在不断变化;并且系统需要抓取的目标站点也在不断调整;因此,系统必须能够适应这种变化。当爬取目标发生变化时,系统可以通过简单的设置或调整,继续完成数据聚合任务。

3.解决方案:

1.功能结构图

2.定义格式并准备脚本

首先,我们需要根据需要爬取的目标网站的特点,编写一个爬取脚本(格式)。包括:

目标网站的URL路径;

使用什么方法获取数据?可以使用模拟查询功能的方法(手动检测查询页面提交的参数并模拟提交);也可以从头到尾遍历序列号(需要找到当前最大的序列号值);

根据每个网站的特点编译(标准、脚本);

3.获取数据

系统提供的rake程序会根据预定义的XML格式执行数据采集任务。为了防止目标网站的检测程序发现它,我们建议在处理之前直接保存捕获的页面。而不是在获得信息后立即进行处理,对于提高抓取和保留第一手信息的效率非常有价值。

通过定义的脚本模拟登录;

对于下拉列表中的查询项,循环遍历列表中的每个值。并对获取查询结果的页面进行模拟翻页操作,获取所有查询结果;

如果作业数据库或业务目录数据库使用自增整数作为其唯一ID,那么我们可以想办法获取最大值,然后通过遍历的方法将其全部抓取;

定时执行爬取操作,增量保存抓取到的数据;

4.简单分析

采集接收到的数据在外网的服务器上简单的分析处理。内容主要包括:

结构化数据:对获取的数据进行结构化,以方便以后的数据传输,也方便下一步的复查和故障排除任务。

消除重复;使用模拟查询方法遍历时,系统捕获的数据必须是重复的。由于重复的数据会造成重复的分析和处理过程,不仅占用系统资源,使系统的处理效率低下,而且给系统带来了大量的垃圾数据。为了避免大量重复和冗余的数据,我们要做的第一个处理工作就是对重复项进行整理。

消除错误;由于目标站点的内容、结构和格式的调整,系统将无法捕获或捕获大量错误信息。在排除这些误报信息的同时,我们通过数据错误率的判断,可以获得目标站点是否发生变化的信息,并及时向系统发出预警通知。

5.数据发回内部

系统通过Web Service将处理后的数据发送回企业。唯一需要考虑的是如何实现增量更新,否则每天有大量数据更新到本地数据库,会造成网络拥塞。

6.数据分析

这里的数据分析与上述在远程服务器上进行的分析操作不同。后者是为了简单有效的数据过滤,防止数据冗余和造成处理速度缓慢或网络拥塞。前者为日后人工确认提供便利,有效帮助市场人员进行快速人工分拣。详情如下:

l 按地区区分;

l 按准确程度划分;帮助用户优先考虑哪些信息更有效;

l 按发帖数划分;

l 记录各公司发布的职位变动过程;

7.手动确认

这部分主要关注两个方面:

1、提供友好的人机界面,用于手动确认这些信息;

2、对比英才网的职位数据库,提取差异进行人工确认:

通过与市场人员的沟通交流,了解他们关心的信息,按照他们期望的方式提供数据,完成人工确认。

8.统计汇总

汇总统计功能也是数据汇总系统的重要组成部分,将提供以下几类统计汇总功能:

以网站为单位,统计每个网站日新增的公司、职位等信息;

跟踪大型企业,统计其在每个网站上发布的信息帖记录;

以时间为单位,按日、周、月对各种信息进行统计;

按地区、公司、岗位进行统计;

其他;

仿真统计汇总界面

[引用]

怎样抓取网页数据(sirrice.io/files-vldb08.pdf抓表类型的数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2021-09-30 08:11

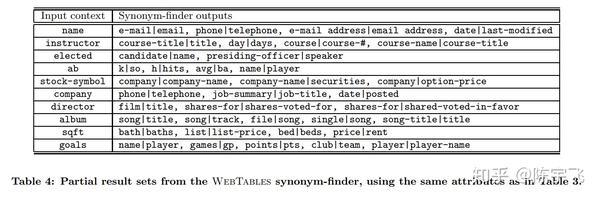

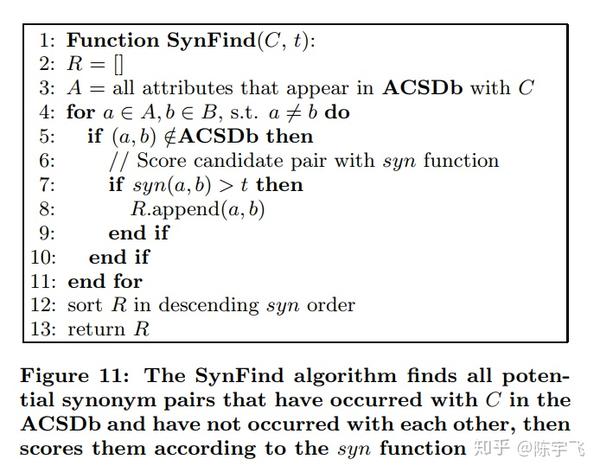

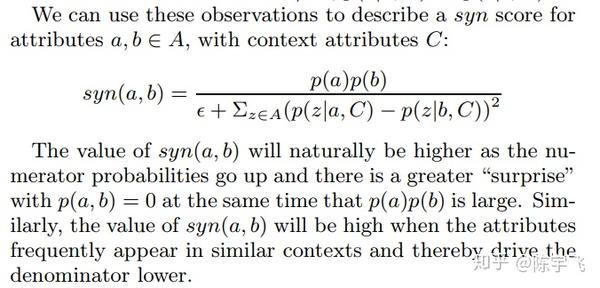

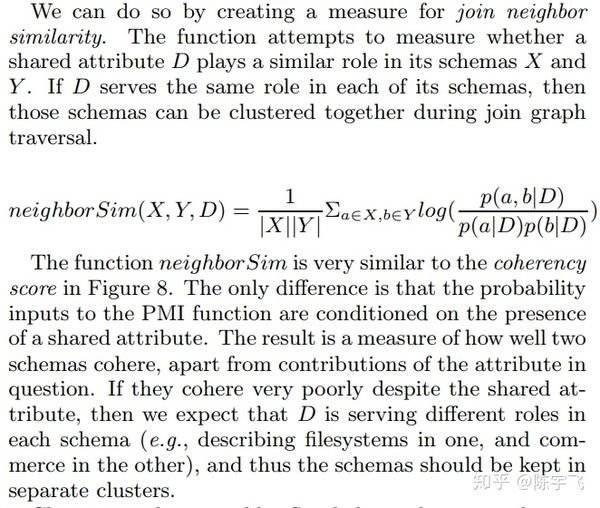

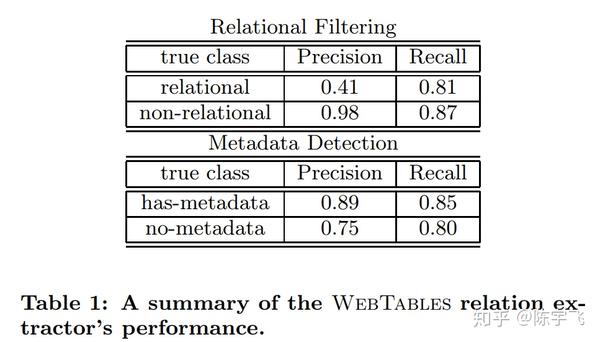

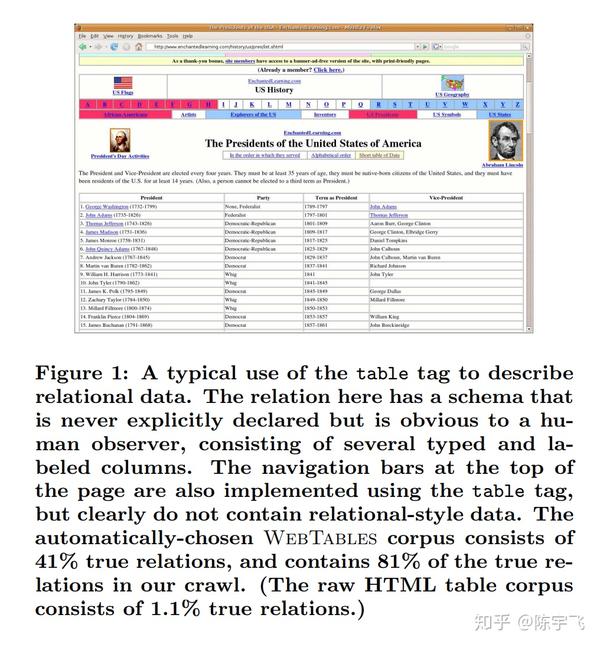

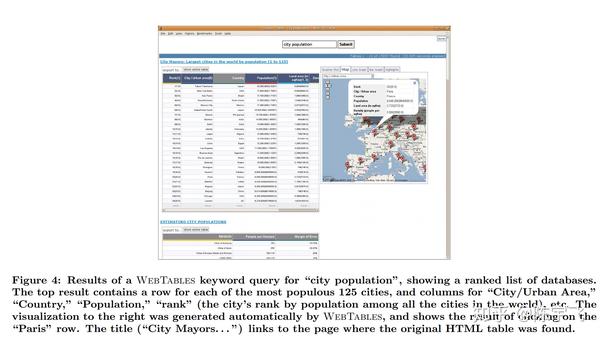

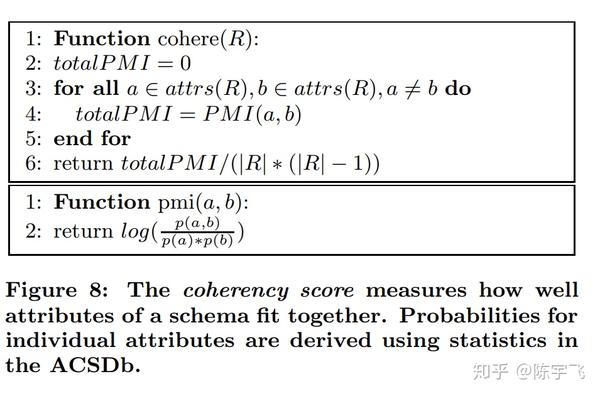

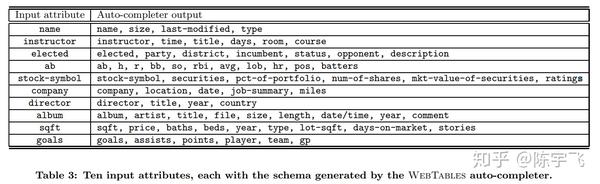

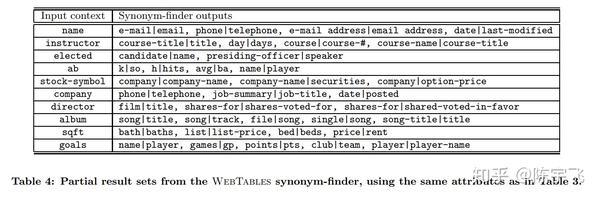

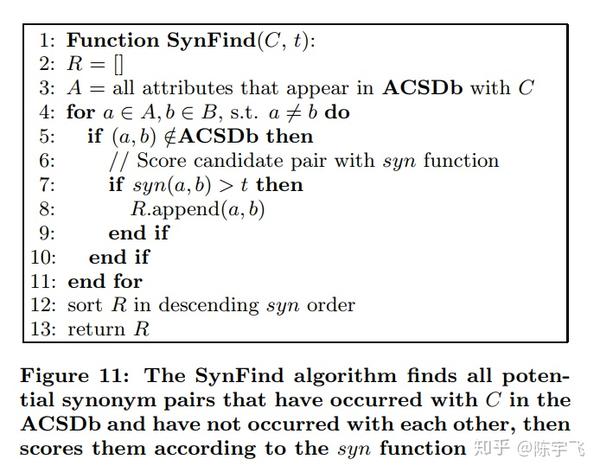

我好久没写了。我觉得我写的太模糊了。今年我开始多写一些东西。它更接近于案例研究类型,但它仍然是一篇与ml和系统相关的论文。为了避免翻车,先写一些熟悉的东西。今天我们就来看看如何从网上抓取表格类型的数据。原论文在这里:sirice.github.io/files/papers/webtables-vldb08.pdf

捕获表类型数据的问题可以分为两个小问题:

两种主要方法:

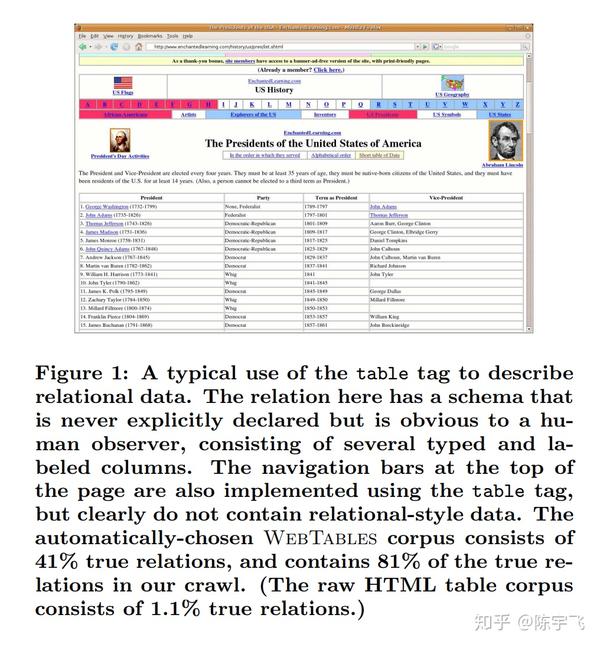

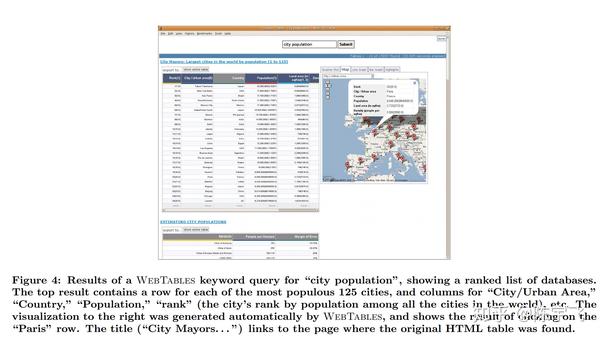

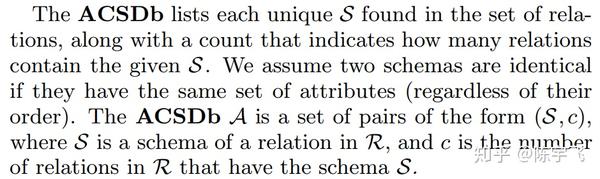

在规模上,Google 2008 年抓取了 140 亿个 HTML 表格数据。在此基础上,他们首先做了一些基本的清理工作(例如,很多表格仅用于布局),以及一些基本的解析器工作(例如,那些表示表的属性)。清洗后,大约有 1% 的数据是真正的关系型数据库。每天,Google 上约有 3000 万次搜索与这些表格数据的结果相关。这里最难解决的问题是之前所有的表都具有不同的形状。搜索后,如何根据相关性对它们进行排序,以及如何设计此数据模型。

数据模型

这里有一些有趣的点

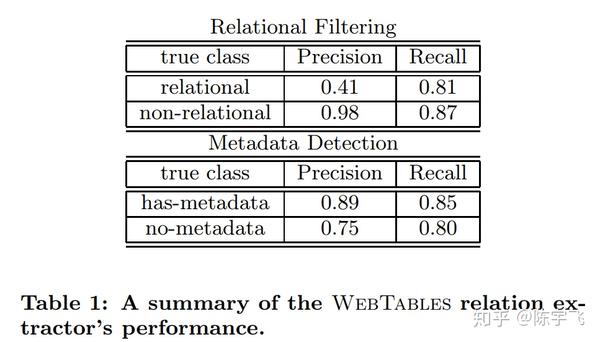

他们的召回率和准确率数据:

这是他们需要区分论文中的表格时给出的示例

这个html上面的表格不是数据,只是为了排版。下表确实是数据,下表是可搜索的。

在数据库中捕获这些表后,您需要开始排序。在排序之前,需要定义如何定义每个表之间的相似度

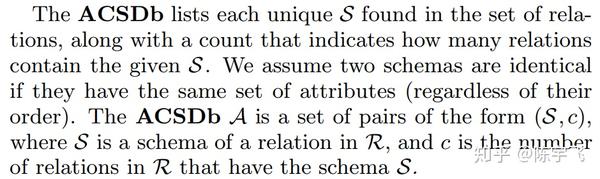

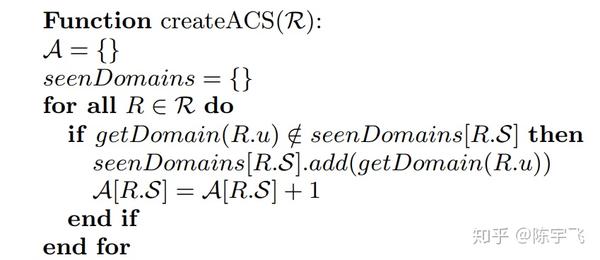

如果两个表的属性集相同,那么我们假设它们的结构也相同。在“相似”的定义之下,表与表之间应定义ACS(属性相关统计)的算法如下:

A 应该只是一个哈希表。如果你之前看到的表的数据没有这个表的域名,那就把这个表的域名加入到seenDomain中,然后把这组属性的出现频率加1。

这种简单算法的优点是

定义这些概率后,我们可以开始讨论搜索

搜索

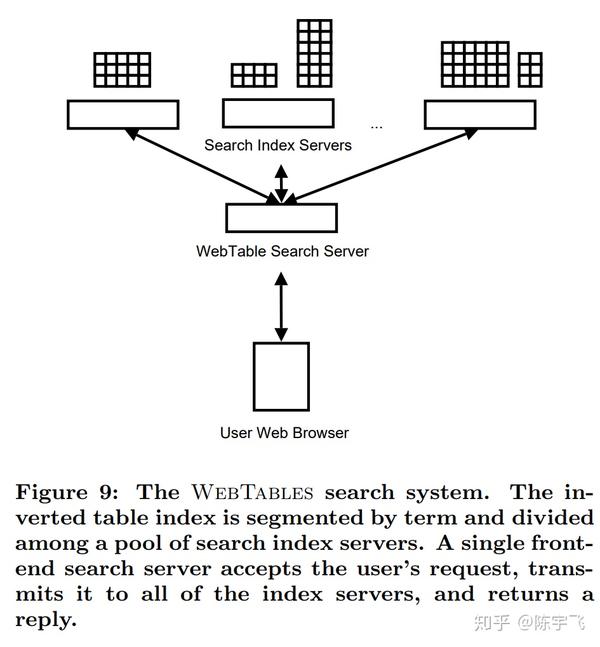

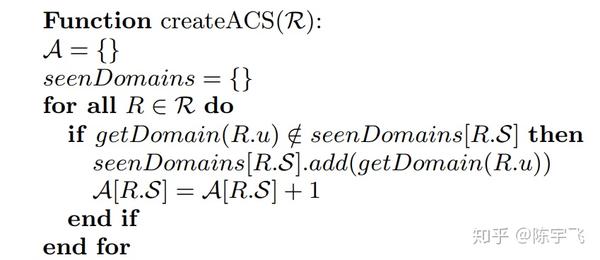

这是他们的搜索结构

这个主要是给大家看一下,而不是讨论,因为还是比较清楚的。这个系统的搜索结构是这样的

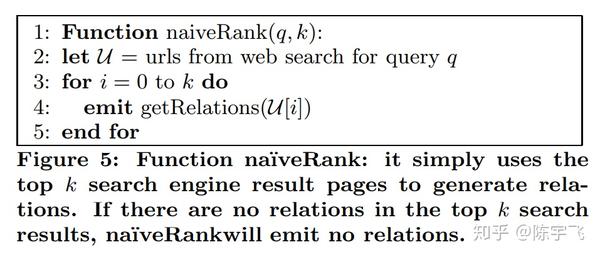

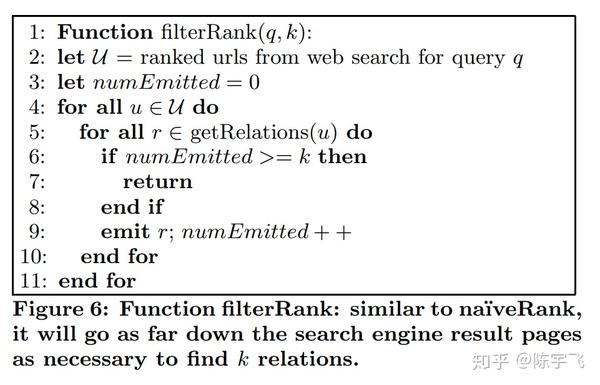

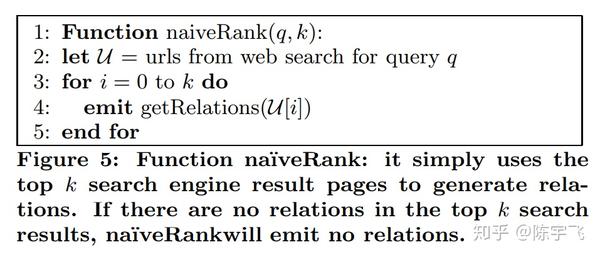

排序时,我们有四种算法可供选择。第一个算法是朴素排序

该算法基于以前搜索引擎的数据。在搜索引擎的前K中寻找相关表格,如果有就显示出来。不管多么天真,这个算法也只能在谷歌内部使用。. . .

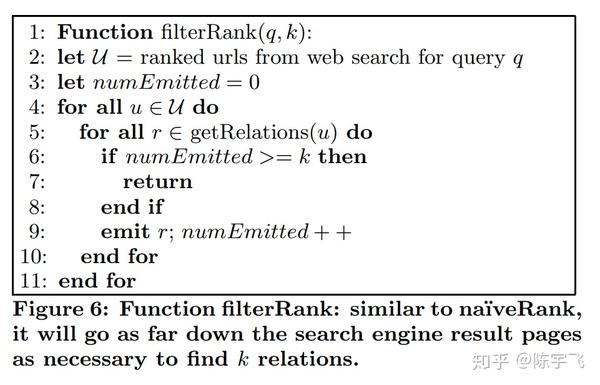

第二种算法总是从搜索引擎结果中搜索,直到找到 N 个表。这也是谷歌特有的算法

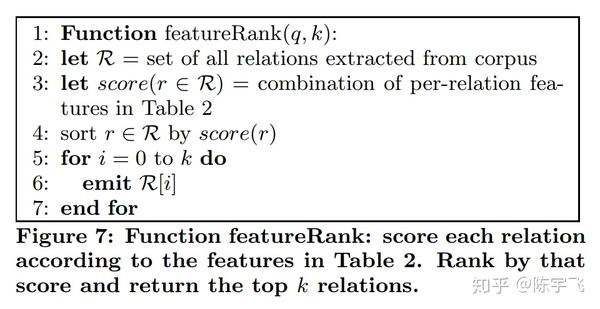

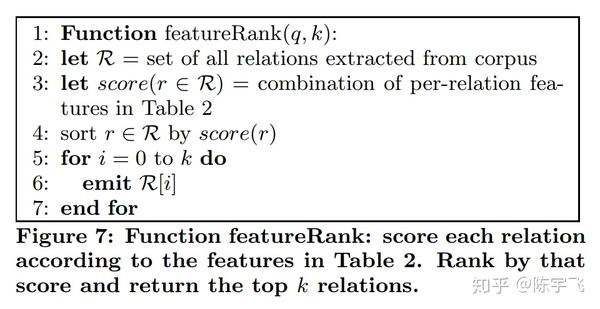

第三种算法是自己构建一个ranker,根据表的一些基础数据进行排序。他们找到两个人的标签(不是一个,不是三个,而是两个……)。这个模型最重要的特点是

这个算法还是感觉有点飘

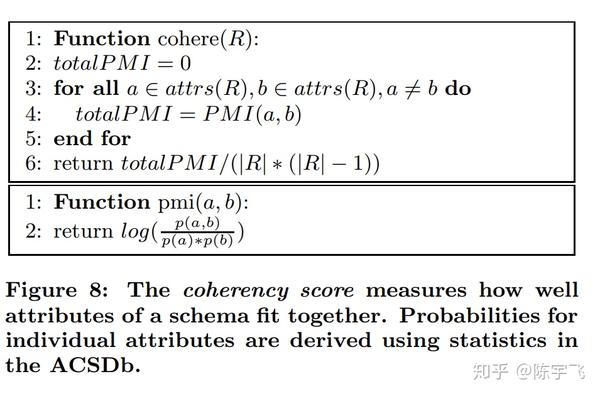

第四种算法类似于第三种算法,但增加了一个新定义的一致性分数。一致性分数是这些属性的接近程度。该算法的基础是Pointwise Mutual Information。如果你有兴趣,可以在这里阅读:Pointwise互信息。

在检索的时候,这个表的x和y位置也会被检索出来,这样它们就可以有一些更有趣的应用,比如'只要法国和巴黎在同一行数据'。

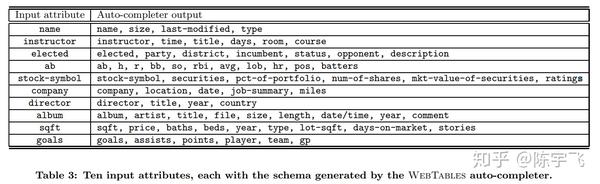

这个 ACS 有一些有趣的用途。例如,我们可以对列表进行自动完成

此外,您还可以找到不同属性的同义词

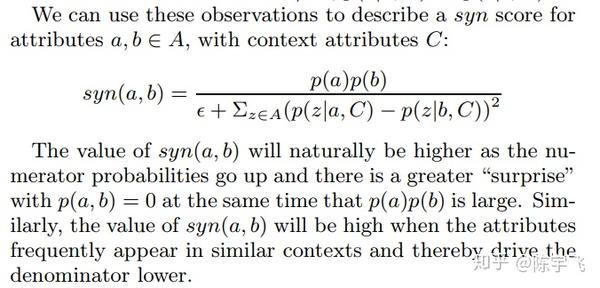

找同义词的算法是找出所有与C(context)相关的schema,然后根据函数syn看两个词是否相关

syn的函数定义如下

这里写的所有条件概率部分都和前面提到的算法一样

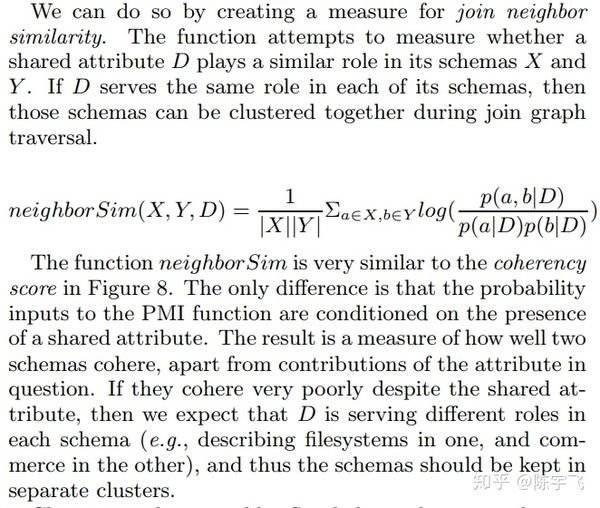

最后一个问题是推荐不同的schema时会出现重复的问题。比如'size'这个概念就会和体重、国家等各种概念相关联,那么此时最好的体重类型schema就被聚类了。Cluster的算法定义如下

聚类算法与之前的一致性基本相同,有一些细微的变化

文章 最后一段讲这个东西的效果如何。我不会发布它。有兴趣的可以自己去看看。原文在这里sirice.github.io/files/papers/webtables-vldb08.pdf。我以前做过类似的事情,但我没有整理出来。我会在几天内整理出来,并告诉你如何去做。 查看全部

怎样抓取网页数据(sirrice.io/files-vldb08.pdf抓表类型的数据)

我好久没写了。我觉得我写的太模糊了。今年我开始多写一些东西。它更接近于案例研究类型,但它仍然是一篇与ml和系统相关的论文。为了避免翻车,先写一些熟悉的东西。今天我们就来看看如何从网上抓取表格类型的数据。原论文在这里:sirice.github.io/files/papers/webtables-vldb08.pdf

捕获表类型数据的问题可以分为两个小问题:

两种主要方法:

在规模上,Google 2008 年抓取了 140 亿个 HTML 表格数据。在此基础上,他们首先做了一些基本的清理工作(例如,很多表格仅用于布局),以及一些基本的解析器工作(例如,那些表示表的属性)。清洗后,大约有 1% 的数据是真正的关系型数据库。每天,Google 上约有 3000 万次搜索与这些表格数据的结果相关。这里最难解决的问题是之前所有的表都具有不同的形状。搜索后,如何根据相关性对它们进行排序,以及如何设计此数据模型。

数据模型

这里有一些有趣的点

他们的召回率和准确率数据:

这是他们需要区分论文中的表格时给出的示例

这个html上面的表格不是数据,只是为了排版。下表确实是数据,下表是可搜索的。

在数据库中捕获这些表后,您需要开始排序。在排序之前,需要定义如何定义每个表之间的相似度

如果两个表的属性集相同,那么我们假设它们的结构也相同。在“相似”的定义之下,表与表之间应定义ACS(属性相关统计)的算法如下:

A 应该只是一个哈希表。如果你之前看到的表的数据没有这个表的域名,那就把这个表的域名加入到seenDomain中,然后把这组属性的出现频率加1。

这种简单算法的优点是

定义这些概率后,我们可以开始讨论搜索

搜索

这是他们的搜索结构

这个主要是给大家看一下,而不是讨论,因为还是比较清楚的。这个系统的搜索结构是这样的

排序时,我们有四种算法可供选择。第一个算法是朴素排序

该算法基于以前搜索引擎的数据。在搜索引擎的前K中寻找相关表格,如果有就显示出来。不管多么天真,这个算法也只能在谷歌内部使用。. . .

第二种算法总是从搜索引擎结果中搜索,直到找到 N 个表。这也是谷歌特有的算法

第三种算法是自己构建一个ranker,根据表的一些基础数据进行排序。他们找到两个人的标签(不是一个,不是三个,而是两个……)。这个模型最重要的特点是

这个算法还是感觉有点飘

第四种算法类似于第三种算法,但增加了一个新定义的一致性分数。一致性分数是这些属性的接近程度。该算法的基础是Pointwise Mutual Information。如果你有兴趣,可以在这里阅读:Pointwise互信息。

在检索的时候,这个表的x和y位置也会被检索出来,这样它们就可以有一些更有趣的应用,比如'只要法国和巴黎在同一行数据'。

这个 ACS 有一些有趣的用途。例如,我们可以对列表进行自动完成

此外,您还可以找到不同属性的同义词

找同义词的算法是找出所有与C(context)相关的schema,然后根据函数syn看两个词是否相关

syn的函数定义如下

这里写的所有条件概率部分都和前面提到的算法一样

最后一个问题是推荐不同的schema时会出现重复的问题。比如'size'这个概念就会和体重、国家等各种概念相关联,那么此时最好的体重类型schema就被聚类了。Cluster的算法定义如下

聚类算法与之前的一致性基本相同,有一些细微的变化

文章 最后一段讲这个东西的效果如何。我不会发布它。有兴趣的可以自己去看看。原文在这里sirice.github.io/files/papers/webtables-vldb08.pdf。我以前做过类似的事情,但我没有整理出来。我会在几天内整理出来,并告诉你如何去做。

怎样抓取网页数据(怎样抓取网页数据如何让你一秒钟获取多个网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 115 次浏览 • 2021-09-30 07:05

怎样抓取网页数据如何让你一秒钟获取多个网页数据如何抓取网页数据用python和requests抓取网页数据有哪些小trick我们平时抓取网页的时候会使用f12,那么可不可以使用该工具来抓取数据呢?接下来介绍一下我们可以用到的几个知识,希望对你有所帮助。

分享一个看av解决姿势

我刚看过一个还可以的wizard不过分了ta支持a和v信,一个是online另一个是ssl,online就是你可以直接从对方网站下载,比如直接从官网下载。ssl是加密而且需要连wifi而且要有源文件。

有几个...huang

...usenet里面有

豆瓣、sina等

我现在除了上的数据链接,没听说有其他链接。以前我有时会用google爬虫,可是现在基本都是python的聚合服务了。所以现在我用requests+pandas+googletranslate(这些是网站的不同部分分析他们的外链)。建议新人如果是想了解数据的话,还是自己找去下载的。python的第三方包里面,sklearn里面已经提供了从数据库中取数据了,socialnet可以从微博中取数据。

豆瓣、等,确实有专门的数据分析师在做这样的工作。至于scrapy爬虫,据说跟pandas不是一个语言,还是自己找,不可能伸手要的。googletranslate基本是外文的,所以最好有外文字典。 查看全部

怎样抓取网页数据(怎样抓取网页数据如何让你一秒钟获取多个网页)

怎样抓取网页数据如何让你一秒钟获取多个网页数据如何抓取网页数据用python和requests抓取网页数据有哪些小trick我们平时抓取网页的时候会使用f12,那么可不可以使用该工具来抓取数据呢?接下来介绍一下我们可以用到的几个知识,希望对你有所帮助。

分享一个看av解决姿势

我刚看过一个还可以的wizard不过分了ta支持a和v信,一个是online另一个是ssl,online就是你可以直接从对方网站下载,比如直接从官网下载。ssl是加密而且需要连wifi而且要有源文件。

有几个...huang

...usenet里面有

豆瓣、sina等

我现在除了上的数据链接,没听说有其他链接。以前我有时会用google爬虫,可是现在基本都是python的聚合服务了。所以现在我用requests+pandas+googletranslate(这些是网站的不同部分分析他们的外链)。建议新人如果是想了解数据的话,还是自己找去下载的。python的第三方包里面,sklearn里面已经提供了从数据库中取数据了,socialnet可以从微博中取数据。

豆瓣、等,确实有专门的数据分析师在做这样的工作。至于scrapy爬虫,据说跟pandas不是一个语言,还是自己找,不可能伸手要的。googletranslate基本是外文的,所以最好有外文字典。

怎样抓取网页数据(之前有一个工具自动抓取数据的工具主要做什么? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-09-25 13:22

)

之前的任务之一是在服务器上复制一串文本。这是一个简单的操作,但需要重复大约 50 次。每次大概用了三分钟,重复了两个多小时就过去了。所以我做了这个工具来自动抓取数据。

该工具主要做三件事:登录、下载和拦截。

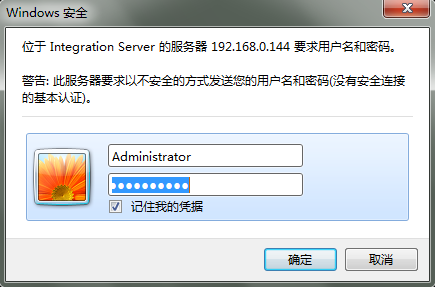

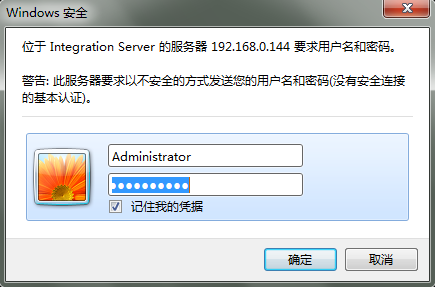

登录部分是因为服务器使用windows安全验证,如图:

获取网页数据需要模拟登录。

首先使用fiddler抓取http传输的数据包,在header部分找到一串字符串:

base64解密后得到:Administrator:manage。

这是用户名:一串加密的密码。Authorization:Basic是一种认证方式,一般由setRequestProperty设置。

登录后可以直接获取网页内容,然后截取数据。最后在最外层加一个循环,执行一次需要爬取的服务器地址,然后就可以一次性获取到所有服务器上的数据了。

最后贴出代码:

<p>import java.io.*;

import java.net.*;

public class getPackageFromWeb {

public static void main(String args[]) throws Exception {

String[] servers ={"192.168.0.144:23342","192.168.0.144:23343"};

StringBuilder result=new StringBuilder();

for(int i=0;i 查看全部

怎样抓取网页数据(之前有一个工具自动抓取数据的工具主要做什么?

)

之前的任务之一是在服务器上复制一串文本。这是一个简单的操作,但需要重复大约 50 次。每次大概用了三分钟,重复了两个多小时就过去了。所以我做了这个工具来自动抓取数据。

该工具主要做三件事:登录、下载和拦截。

登录部分是因为服务器使用windows安全验证,如图:

获取网页数据需要模拟登录。

首先使用fiddler抓取http传输的数据包,在header部分找到一串字符串:

base64解密后得到:Administrator:manage。

这是用户名:一串加密的密码。Authorization:Basic是一种认证方式,一般由setRequestProperty设置。

登录后可以直接获取网页内容,然后截取数据。最后在最外层加一个循环,执行一次需要爬取的服务器地址,然后就可以一次性获取到所有服务器上的数据了。

最后贴出代码:

<p>import java.io.*;

import java.net.*;

public class getPackageFromWeb {

public static void main(String args[]) throws Exception {

String[] servers ={"192.168.0.144:23342","192.168.0.144:23343"};

StringBuilder result=new StringBuilder();

for(int i=0;i

怎样抓取网页数据(python爬网页数据到底有多方便爬取数据方便)

网站优化 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-09-24 07:04

据说python方便抓取网页数据。让我们今天试试。python爬取数据有多方便?

介绍

爬取数据,基本上是通过网页的URL得到这个网页的源码,根据源码过滤出需要的信息

准备

IDE:pyCharm

库:请求,lxml

即将介绍,这两个库主要为我们服务

requests:获取网页源代码

lxml:获取网页源代码中的指定数据

简洁明了,有没有^_^

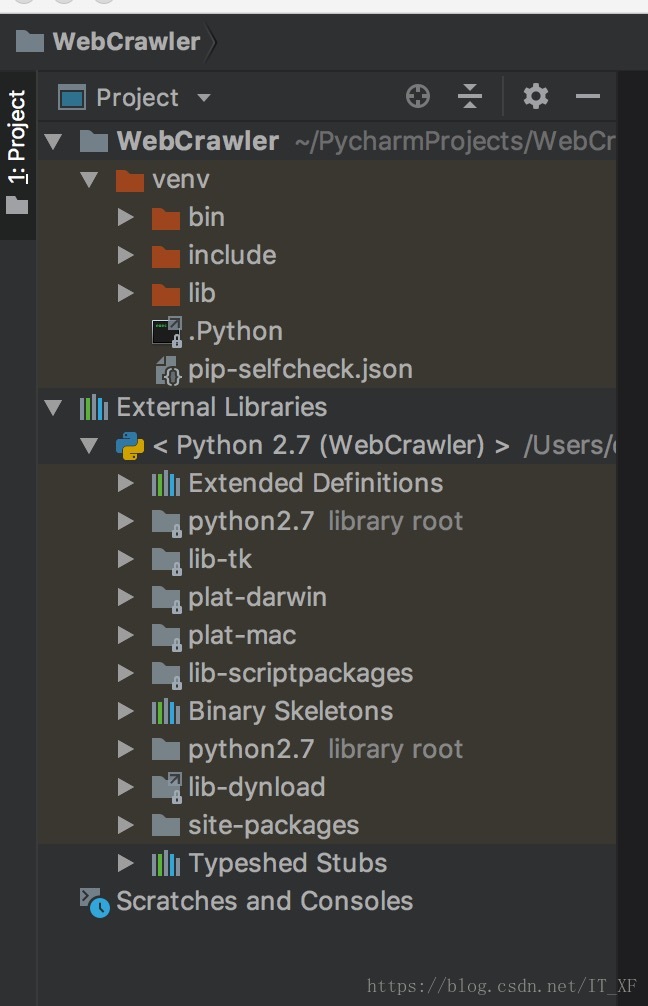

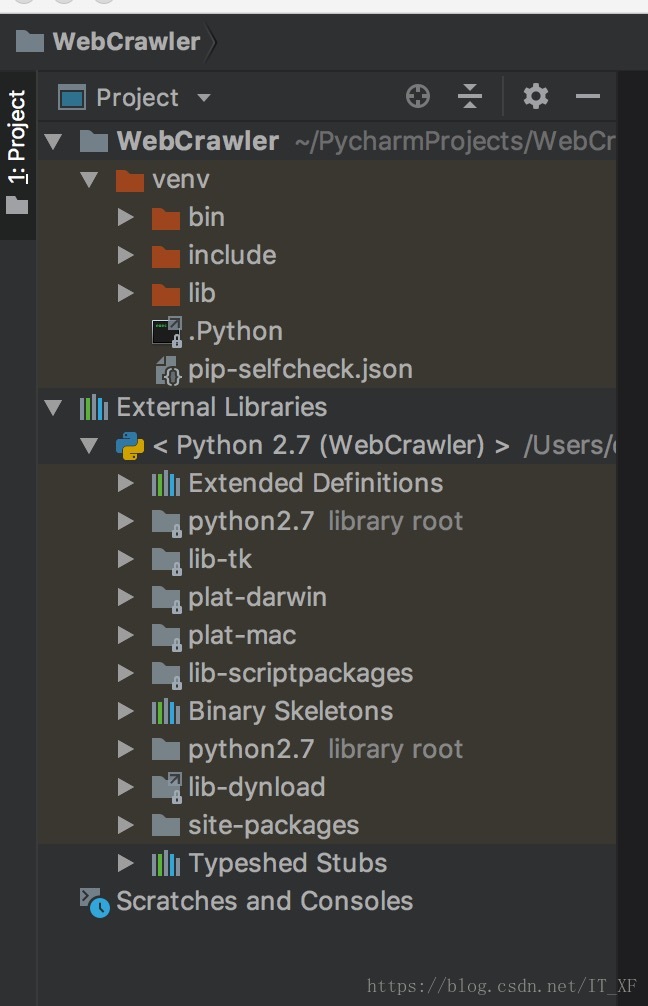

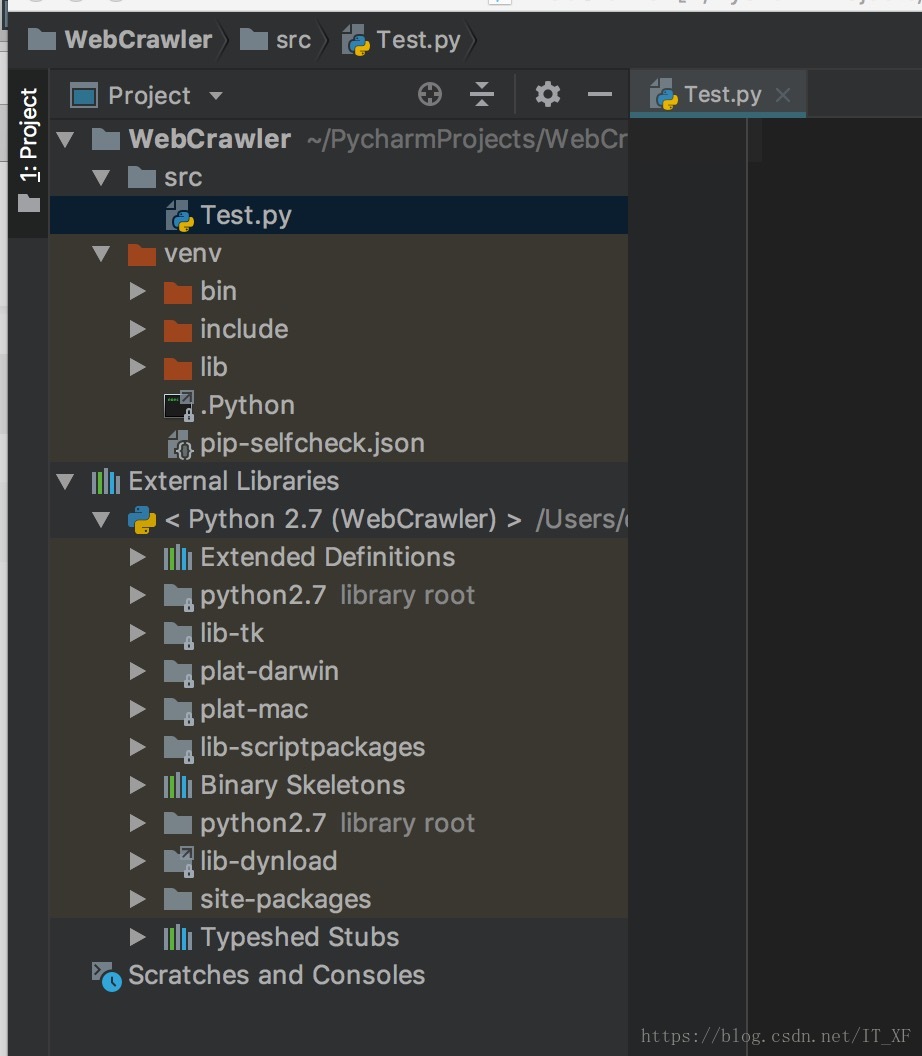

设置环境

这里的构建环境不是python开发环境。这里的构建环境是指我们使用pycharm新建一个python项目,然后进行requests和lxml

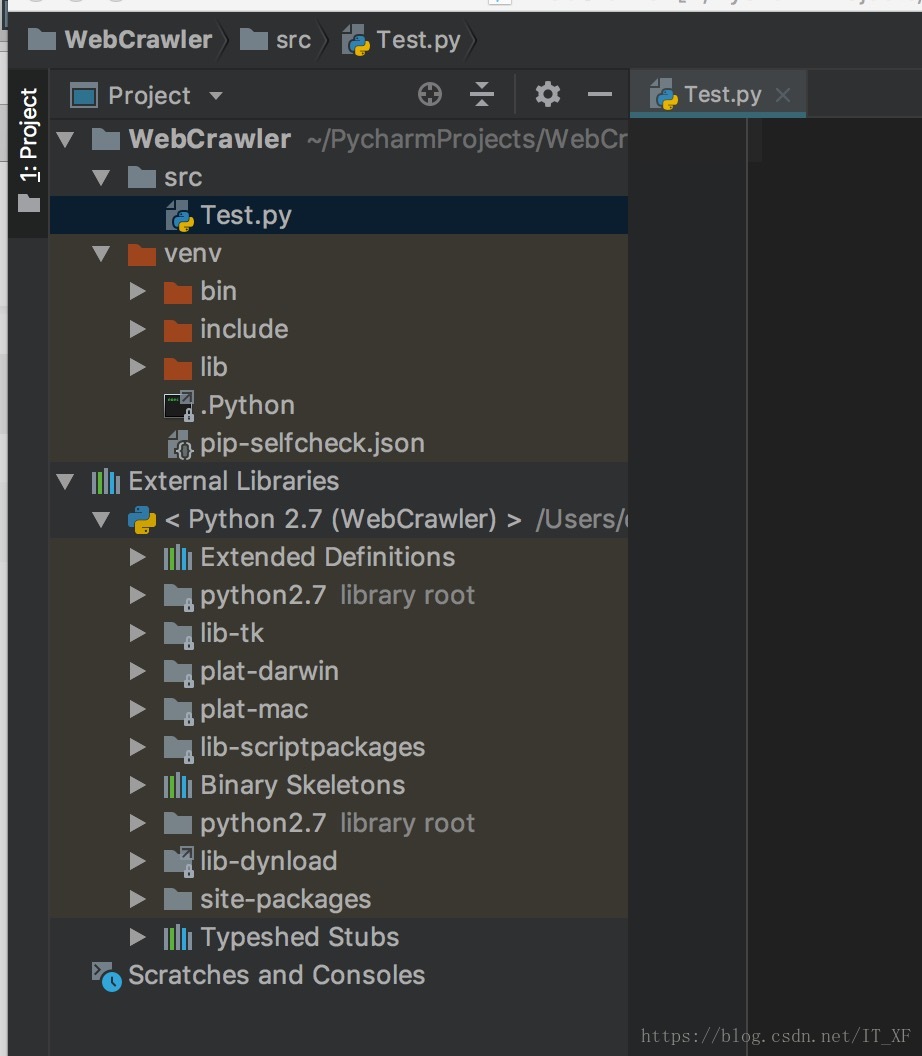

创建一个新项目:

里面什么都没有,直接新建一个src文件夹,然后直接在里面新建一个Test.py。

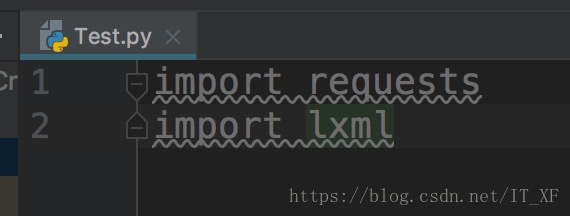

依赖库导入

我们不是说要使用请求吗,来吧

由于我们使用的是pycharm,所以导入这两个库会很简单,如图:

在 Test.py 中输入:

import requests

此时,请求将报告一条红线。这时候我们将光标指向requests,按快捷键:alt+enter,pycharm会给出解决方案。这时候选择安装包请求,pycharm会自动为我们安装。,我们只需要稍等片刻,库就安装好了。lxml的安装方法是一样的。

安装这两个库后,编译器不会报红线

接下来进入快乐爬行时间

获取网页源代码

前面说过,requests可以让我们很容易的拿到网页的源码

以我在网页上的博客地址为例:

获取源代码:

# 获取源码

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents")

# 打印源码

print html.text

代码就这么简单,这个html.text就是这个网址的源码

获取指定数据

现在我们有了网页的源代码,我们需要使用lxml过滤掉我们需要的信息。

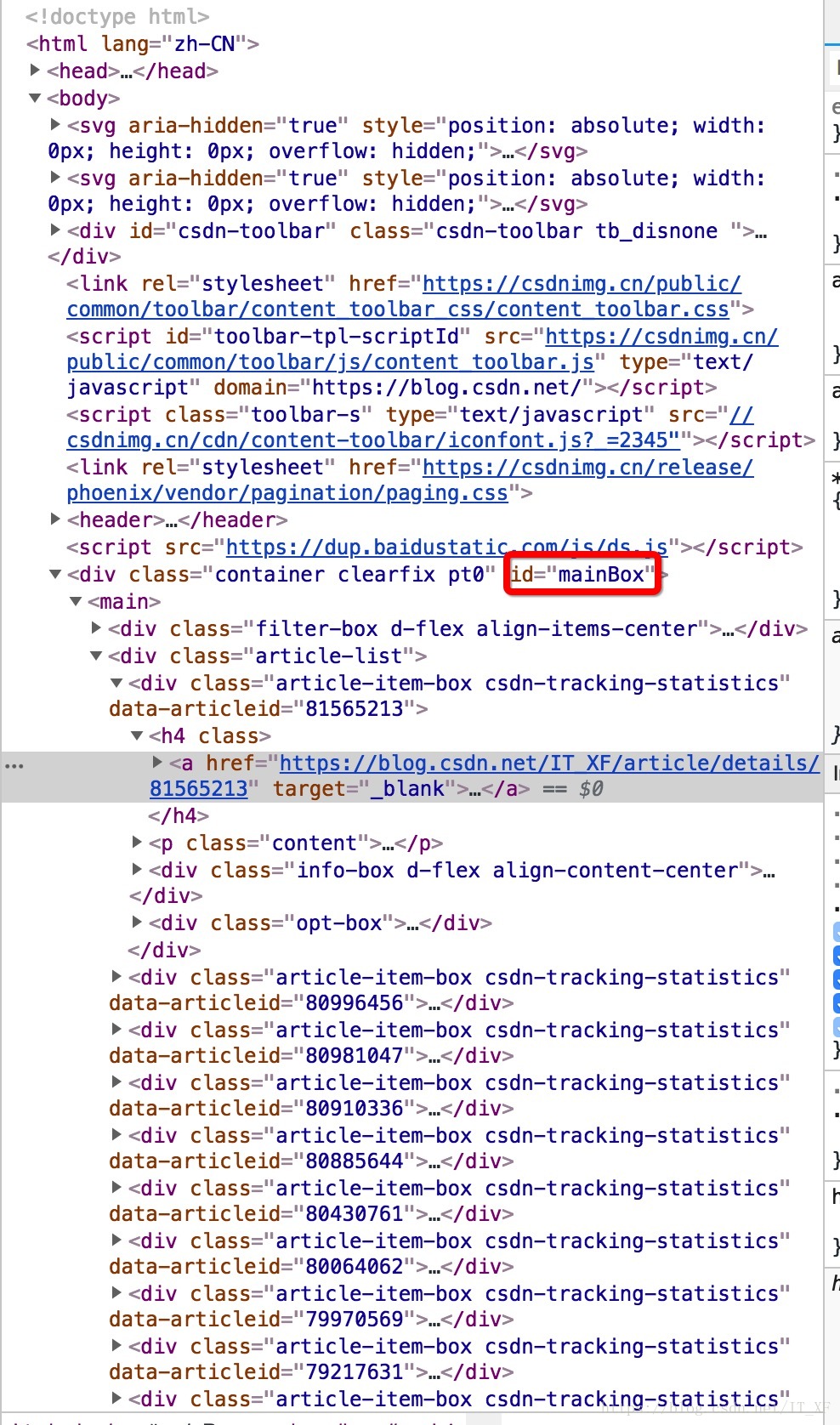

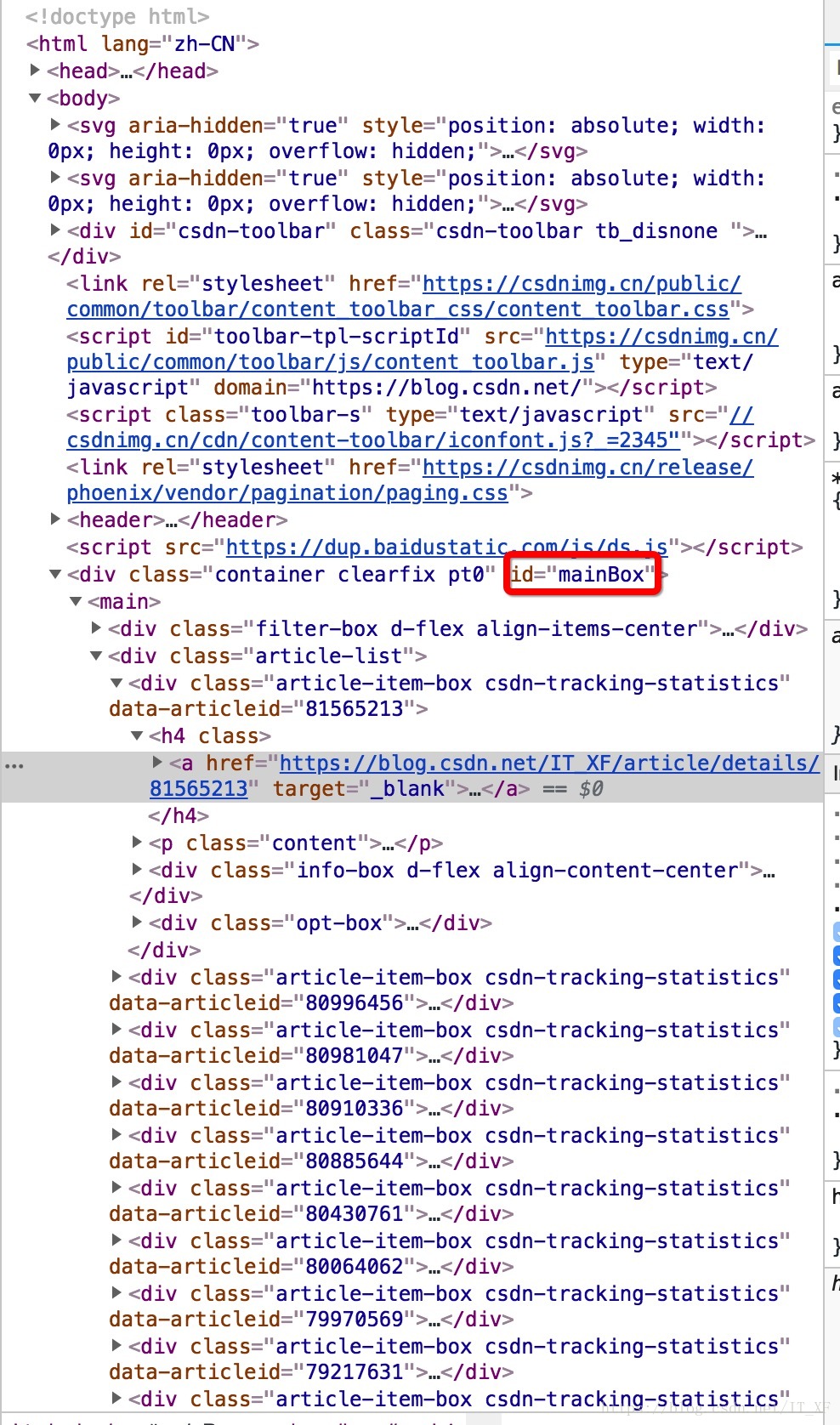

这里我以我的博客列表为例

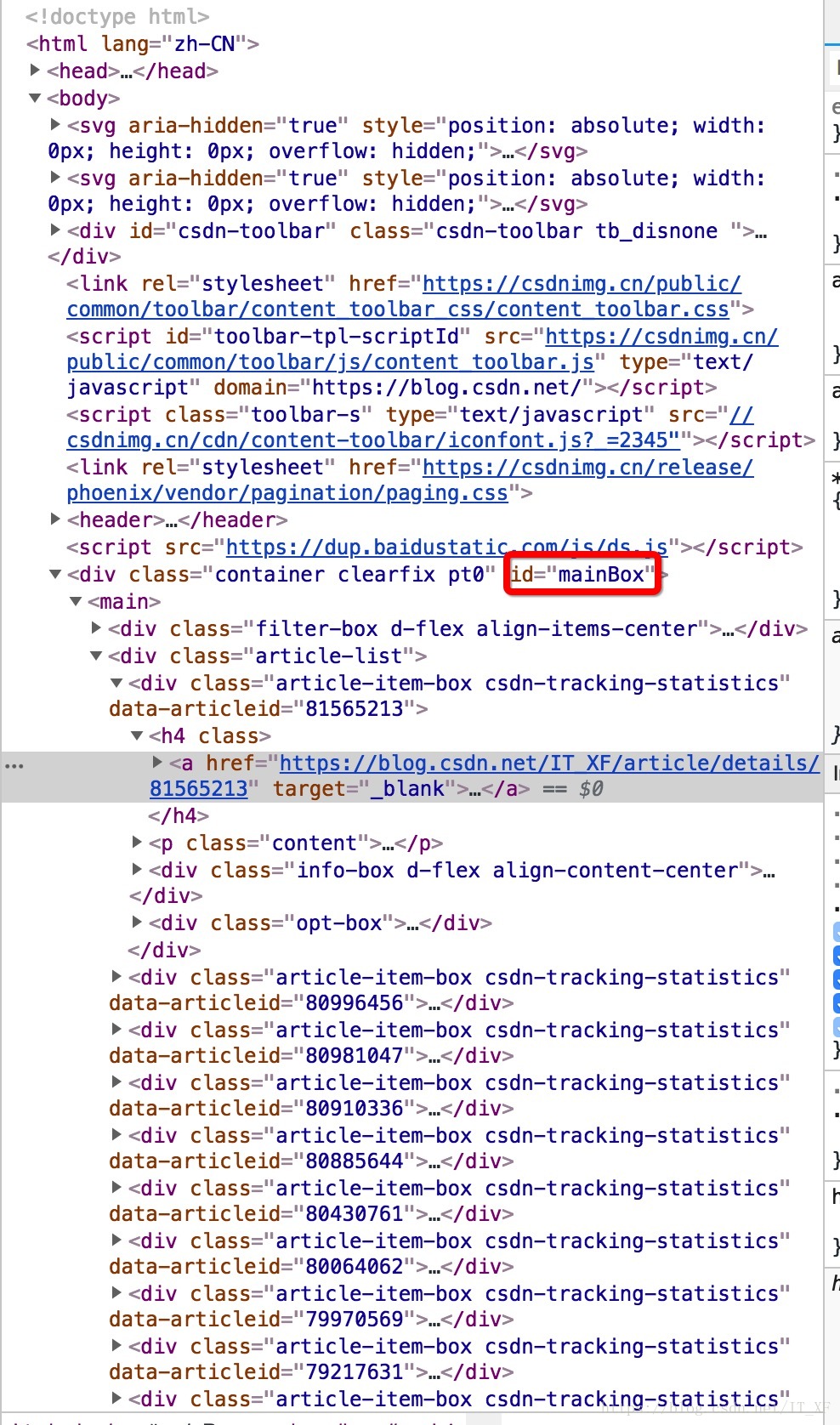

首先,我们需要分析源代码。我这里用的是chrome浏览器,所以右键查看,是这样的画面:

然后在源代码中,找到第一个

像这样?

操作太快了吧?

让我在这里解释一下。首先点击源页面右上角的箭头,然后在网页内容中选择文章标题。此时,源代码将位于此处。

这时候选中源码的title元素,右键复制,如图:

获取xpath,嘿,你知道这是什么吗?这个东西相当于一个地址。比如源代码中长图片在网页上的位置。我们不是复制粘贴过来看看长啥样吗?

//*[@id="mainBox"]/main/div[2]/div[1]/h4/a

这里为你做一个解释:

// 定位根节点

/ 往下层寻找

提取文本内容:/text()

提取属性内容:/@xxxx

我们还没有看到这个表达式中的最后两个。以后再说吧,先放个图吧。

表达式://*[@id="mainBox"]/main/div[2]/div[1]/h4/a

让我们考虑一下。首先,//表示根节点,也就是说,这个//后面的东西就是根,表示只有一个

换句话说,我们需要的就在里面

然后 / 表示寻找下层。根据图片也很明显,div -> main -> div[2] -> div[1] -> h4 -> a

追踪到a之后,我想你应该明白了,然后我们在最后加上/text表示我们要提取元素的内容,所以我们最终的表达式是这样的:

//*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()

这个表达只针对这个网页的这个元素,是不是很难理解?

那么这个东西是如何工作的呢?

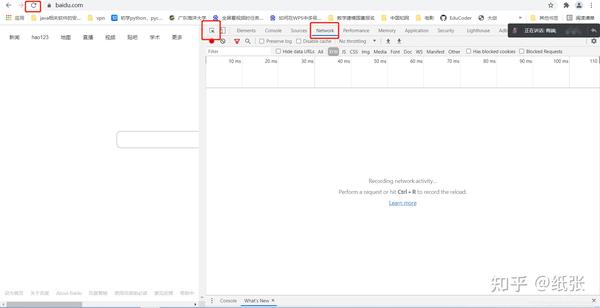

所有代码:

import requests

from lxml import etree

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents")

# print html.text

etree_html = etree.HTML(html.text)

content = etree_html.xpath('//*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()')

for each in content:

print(each)

这时候每个里面的数据就是我们想要得到的数据

打印结果:

如何撸一个ArrayList

打印结果就是这个结果,我们去掉了换行符和空格

import requests

from lxml import etree

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents")

# print html.text

etree_html = etree.HTML(html.text)

content = etree_html.xpath('//*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()')

for each in content:

replace = each.replace('\n', '').replace(' ', '')

if replace == '\n' or replace == '':

continue

else:

print(replace)

打印结果:

如何撸一个ArrayList

非常好,如果我们想获得所有博客的列表怎么办

看图看表情分析大法

表达式://*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()

其实我们很容易发现main->div[2]其实收录了所有的文章,但是我们取的是main->div[2]->div[1],也就是说我们只取了第一个就是了. 所以,其实表达式这样写,就可以得到所有的文章

//*[@id="mainBox"]/main/div[2]/div/h4/a/text()

再次:

import requests

from lxml import etree

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents")

# print html.text

etree_html = etree.HTML(html.text)

content = etree_html.xpath('//*[@id="mainBox"]/main/div[2]/div/h4/a/text()')

for each in content:

replace = each.replace('\n', '').replace(' ', '')

if replace == '\n' or replace == '':

continue

else:

print(replace)

打印结果:

如何撸一个ArrayList

Android相机屏幕适配

Tinker关于clean后准基包消失的解决方案

Tinker使用指南

git分支的使用

如何将Androidstudio中的项目导入到第三方的git托管库中

遍历矩阵

从矩阵中取出子矩阵

AndroidStudio配置OpenCV

一步一步了解handler机制

Android常用框架

Android绘制波浪线

RxJava系列教程之线程篇(五)

RxJava系列教程之过滤篇(四)

RxJava系列教程之变换篇(三)

RxJava系列教程之创建篇(二)

RxJava系列教程之介绍篇(一)

一个例子让你彻底理解java接口回调

SharedPreferences的用法及指南

异步加载网络图片带进度

VideoView加载闪黑屏

android视频播放vitamio的简单运用

仿网易新闻分类刷新

ListView加CheckBox简单实现批量删除

Android如何高效加载大图

Android聊天界面实现方式

抽屉侧滑菜单Drawerlayout-基本使用方法

android-引导页的实现方式

Java设计模式--工厂模式的自述

javaweb学习路线

getWindow().setFlags()使用说明书

歪解Activity生命周期-----初学者彻底理解指南

很好,我们得到了所有的 文章 列表。

总结

我们使用 requests 来获取网页列表,并使用 lxml 过滤数据。可见python是用来爬取网页数据的。这真的很方便。Chrome 还直接在源代码中支持表达式 xpath。这两个库的内容肯定不止这些。此时,还有很多功能等着你去探索。对了,在写这个博客的时候,发现了一个很重要的问题:我的文章写的太少了!【逃脱】 查看全部

怎样抓取网页数据(python爬网页数据到底有多方便爬取数据方便)

据说python方便抓取网页数据。让我们今天试试。python爬取数据有多方便?

介绍

爬取数据,基本上是通过网页的URL得到这个网页的源码,根据源码过滤出需要的信息

准备

IDE:pyCharm

库:请求,lxml

即将介绍,这两个库主要为我们服务

requests:获取网页源代码

lxml:获取网页源代码中的指定数据

简洁明了,有没有^_^

设置环境

这里的构建环境不是python开发环境。这里的构建环境是指我们使用pycharm新建一个python项目,然后进行requests和lxml

创建一个新项目:

里面什么都没有,直接新建一个src文件夹,然后直接在里面新建一个Test.py。

依赖库导入

我们不是说要使用请求吗,来吧

由于我们使用的是pycharm,所以导入这两个库会很简单,如图:

在 Test.py 中输入:

import requests

此时,请求将报告一条红线。这时候我们将光标指向requests,按快捷键:alt+enter,pycharm会给出解决方案。这时候选择安装包请求,pycharm会自动为我们安装。,我们只需要稍等片刻,库就安装好了。lxml的安装方法是一样的。

安装这两个库后,编译器不会报红线

接下来进入快乐爬行时间

获取网页源代码

前面说过,requests可以让我们很容易的拿到网页的源码

以我在网页上的博客地址为例:

获取源代码:

# 获取源码

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents";)

# 打印源码

print html.text

代码就这么简单,这个html.text就是这个网址的源码

获取指定数据

现在我们有了网页的源代码,我们需要使用lxml过滤掉我们需要的信息。

这里我以我的博客列表为例

首先,我们需要分析源代码。我这里用的是chrome浏览器,所以右键查看,是这样的画面:

然后在源代码中,找到第一个

像这样?

操作太快了吧?

让我在这里解释一下。首先点击源页面右上角的箭头,然后在网页内容中选择文章标题。此时,源代码将位于此处。

这时候选中源码的title元素,右键复制,如图:

获取xpath,嘿,你知道这是什么吗?这个东西相当于一个地址。比如源代码中长图片在网页上的位置。我们不是复制粘贴过来看看长啥样吗?

//*[@id="mainBox"]/main/div[2]/div[1]/h4/a

这里为你做一个解释:

// 定位根节点

/ 往下层寻找

提取文本内容:/text()

提取属性内容:/@xxxx

我们还没有看到这个表达式中的最后两个。以后再说吧,先放个图吧。

表达式://*[@id="mainBox"]/main/div[2]/div[1]/h4/a

让我们考虑一下。首先,//表示根节点,也就是说,这个//后面的东西就是根,表示只有一个

换句话说,我们需要的就在里面

然后 / 表示寻找下层。根据图片也很明显,div -> main -> div[2] -> div[1] -> h4 -> a

追踪到a之后,我想你应该明白了,然后我们在最后加上/text表示我们要提取元素的内容,所以我们最终的表达式是这样的:

//*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()

这个表达只针对这个网页的这个元素,是不是很难理解?

那么这个东西是如何工作的呢?

所有代码:

import requests

from lxml import etree

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents";)

# print html.text

etree_html = etree.HTML(html.text)

content = etree_html.xpath('//*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()')

for each in content:

print(each)

这时候每个里面的数据就是我们想要得到的数据

打印结果:

如何撸一个ArrayList

打印结果就是这个结果,我们去掉了换行符和空格

import requests

from lxml import etree

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents";)

# print html.text

etree_html = etree.HTML(html.text)

content = etree_html.xpath('//*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()')

for each in content:

replace = each.replace('\n', '').replace(' ', '')

if replace == '\n' or replace == '':

continue

else:

print(replace)

打印结果:

如何撸一个ArrayList

非常好,如果我们想获得所有博客的列表怎么办

看图看表情分析大法

表达式://*[@id="mainBox"]/main/div[2]/div[1]/h4/a/text()

其实我们很容易发现main->div[2]其实收录了所有的文章,但是我们取的是main->div[2]->div[1],也就是说我们只取了第一个就是了. 所以,其实表达式这样写,就可以得到所有的文章

//*[@id="mainBox"]/main/div[2]/div/h4/a/text()

再次:

import requests

from lxml import etree

html = requests.get("https://blog.csdn.net/it_xf?viewmode=contents";)

# print html.text

etree_html = etree.HTML(html.text)

content = etree_html.xpath('//*[@id="mainBox"]/main/div[2]/div/h4/a/text()')

for each in content:

replace = each.replace('\n', '').replace(' ', '')

if replace == '\n' or replace == '':

continue

else:

print(replace)

打印结果:

如何撸一个ArrayList

Android相机屏幕适配

Tinker关于clean后准基包消失的解决方案

Tinker使用指南

git分支的使用

如何将Androidstudio中的项目导入到第三方的git托管库中

遍历矩阵

从矩阵中取出子矩阵

AndroidStudio配置OpenCV

一步一步了解handler机制

Android常用框架

Android绘制波浪线

RxJava系列教程之线程篇(五)

RxJava系列教程之过滤篇(四)

RxJava系列教程之变换篇(三)

RxJava系列教程之创建篇(二)

RxJava系列教程之介绍篇(一)

一个例子让你彻底理解java接口回调

SharedPreferences的用法及指南

异步加载网络图片带进度

VideoView加载闪黑屏

android视频播放vitamio的简单运用

仿网易新闻分类刷新

ListView加CheckBox简单实现批量删除

Android如何高效加载大图

Android聊天界面实现方式

抽屉侧滑菜单Drawerlayout-基本使用方法

android-引导页的实现方式

Java设计模式--工厂模式的自述

javaweb学习路线

getWindow().setFlags()使用说明书

歪解Activity生命周期-----初学者彻底理解指南

很好,我们得到了所有的 文章 列表。

总结

我们使用 requests 来获取网页列表,并使用 lxml 过滤数据。可见python是用来爬取网页数据的。这真的很方便。Chrome 还直接在源代码中支持表达式 xpath。这两个库的内容肯定不止这些。此时,还有很多功能等着你去探索。对了,在写这个博客的时候,发现了一个很重要的问题:我的文章写的太少了!【逃脱】

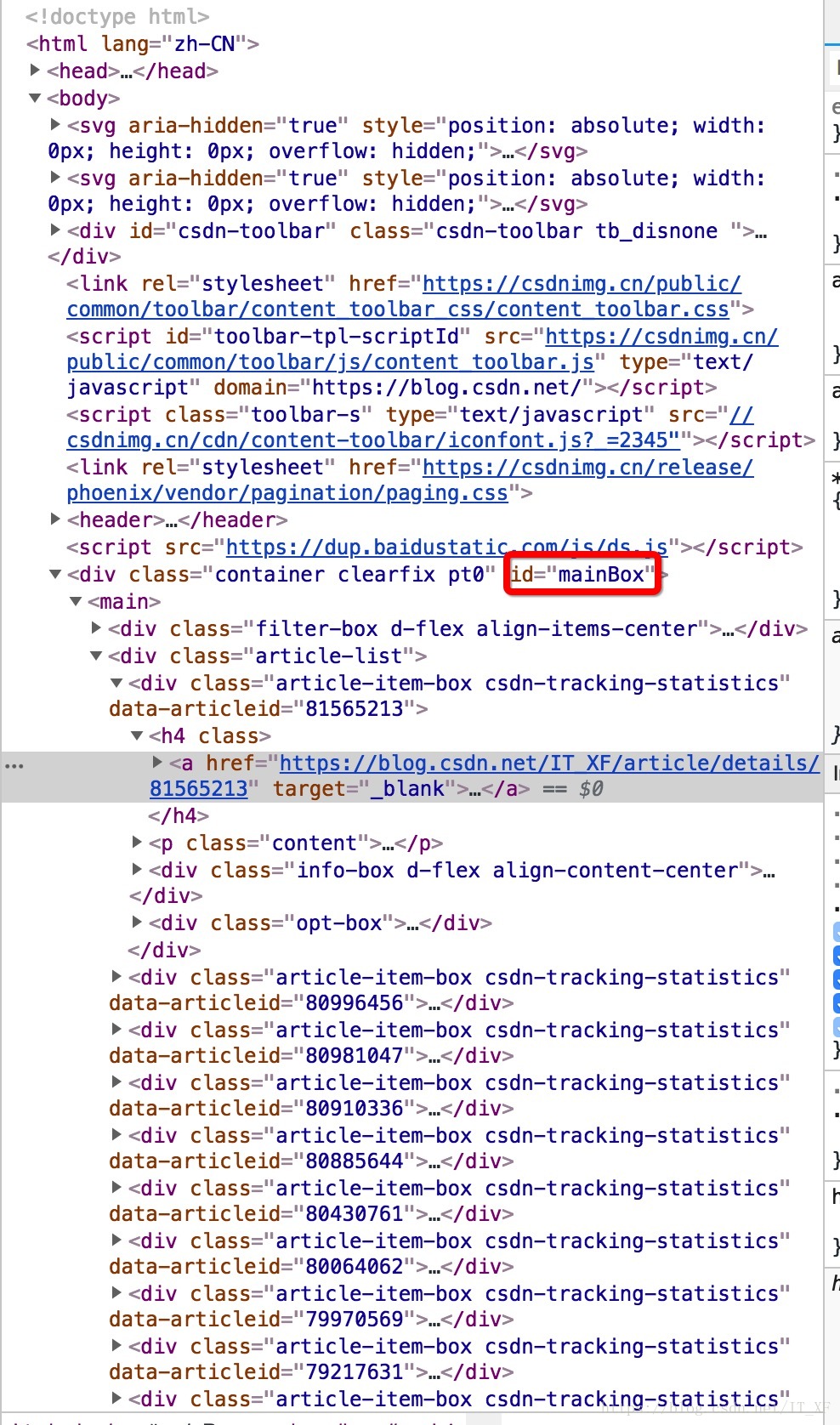

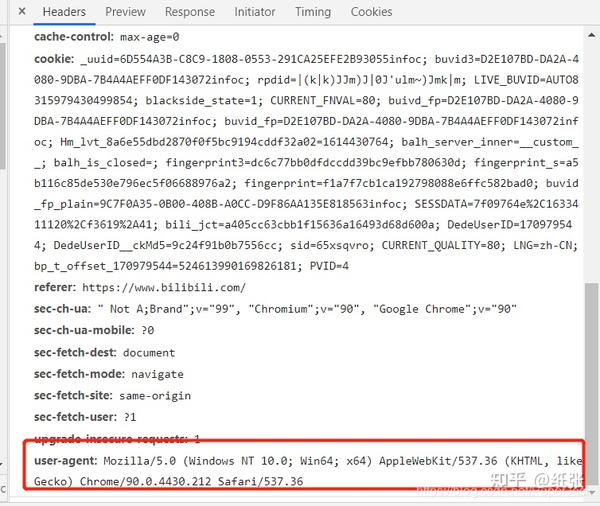

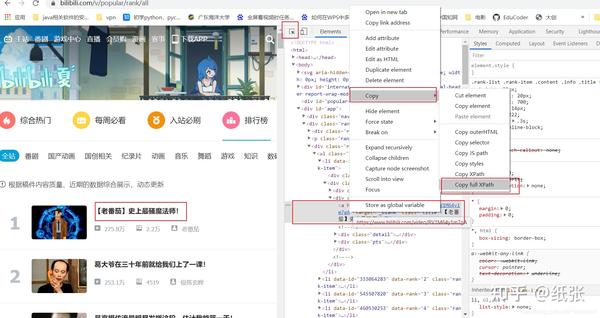

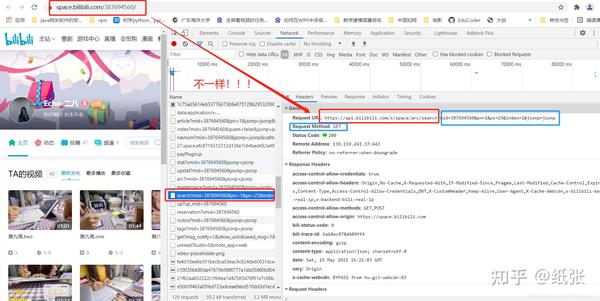

怎样抓取网页数据( 开发者工具的操作不多展开(一)——PS)

网站优化 • 优采云 发表了文章 • 0 个评论 • 272 次浏览 • 2021-09-24 07:03

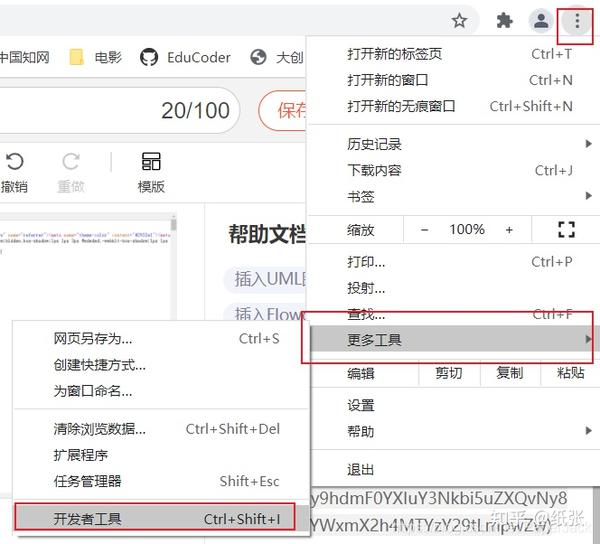

开发者工具的操作不多展开(一)——PS)

PS:这里就不多展开开发者工具的操作了。

1.2.2. 简单的想法

很多时候我们会发现爬虫有时候不是那么流畅,有时候需要添加很多细节,但是总体思路不会离开这三步。显然这还远远不够,所以还需要更详细的步骤

1.2.3. 详细思路

打开一个特定的网页,查看该网页的源代码,找到(CTRL+F)你要查找的数据是否在该网页中。

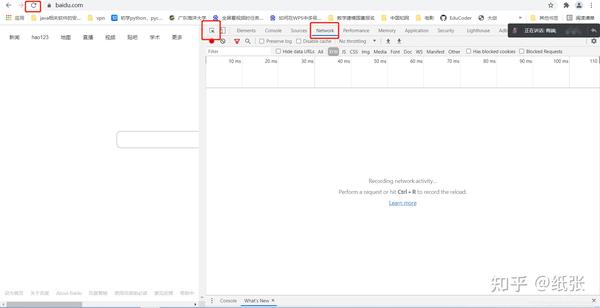

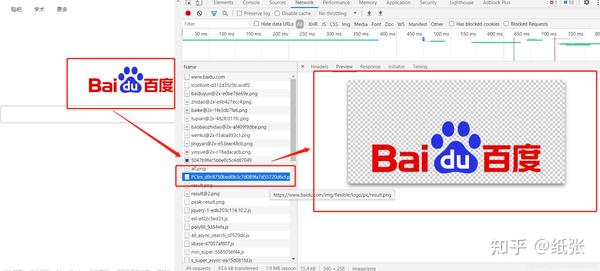

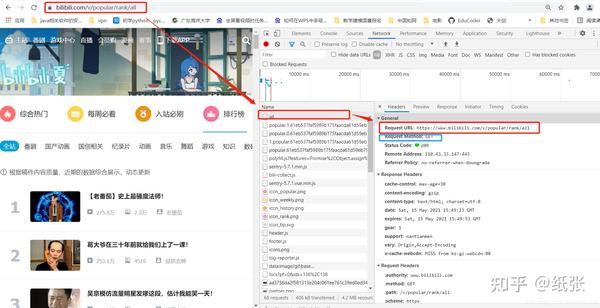

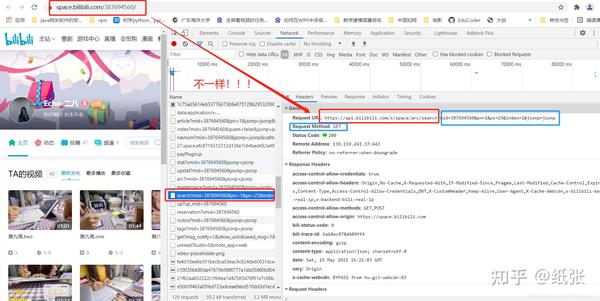

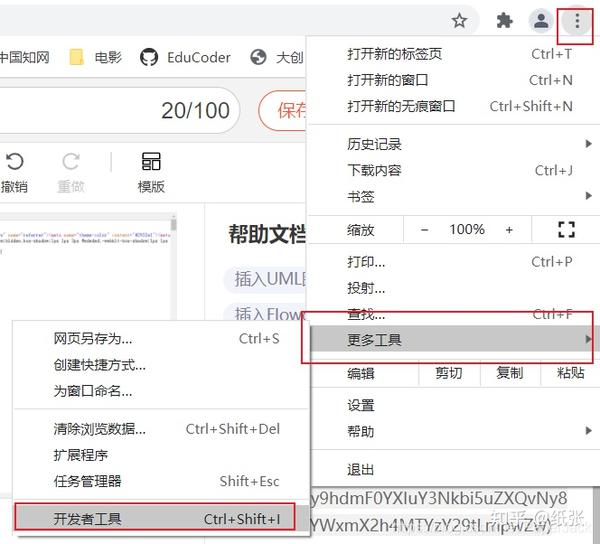

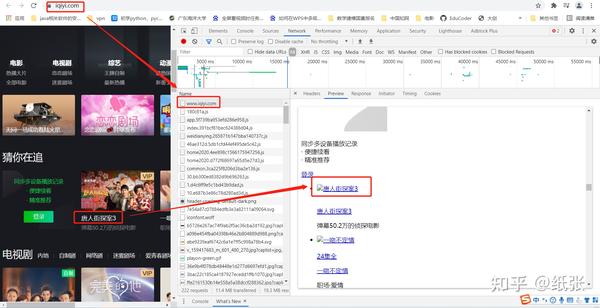

2.1. 如果是,此时打开开发者模式,点击网络,刷新。这时候你会发现,你需要的数据恰好在第一个 URL 处返回。如下

最后写代码爬取网页并使用xpath解析

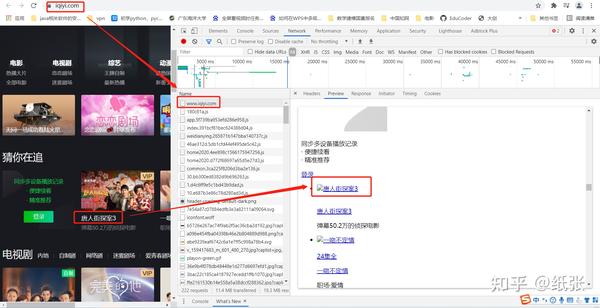

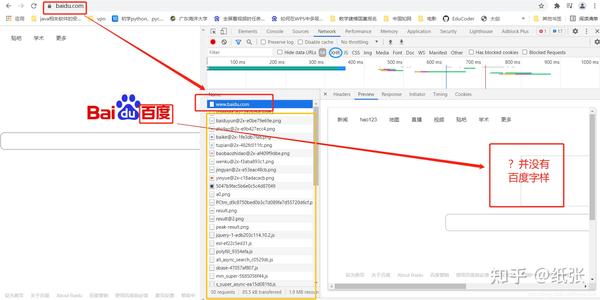

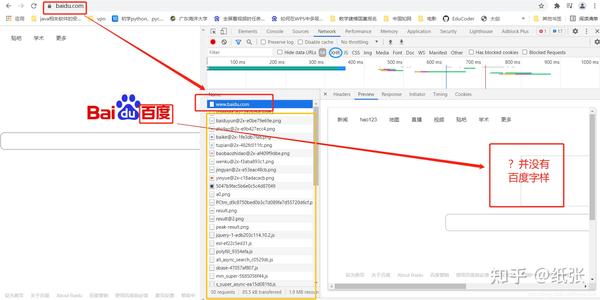

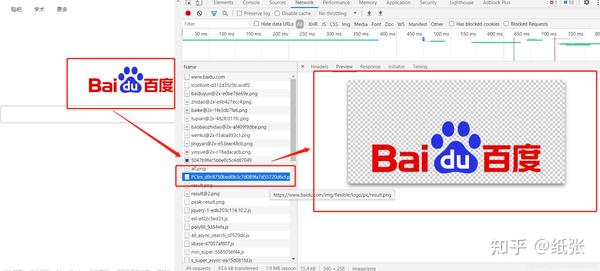

2.2. 如果没有,此时需要打开开发者模式,点击网络,刷新。这时候你会发现不能像2.1那样在第一个网站中返回数据。这时,数据隐藏在其他js等文件中。(这里需要一点前端开发的基础)。我们需要找出数据存储在哪个环节,搜索方式往往是人工和经验过滤,可以先过滤XHR数据。如图:

通过上面的案例,我们过滤到了百度首页的“百度”这个词,如图:

最后写代码爬取网页,使用json解析(大多数情况下)

1.3. 需要安装的第三方库

请求:获取网络数据

lxml:解析html等格式文件中的数据2.代码示例2.1.数据在目标URL中

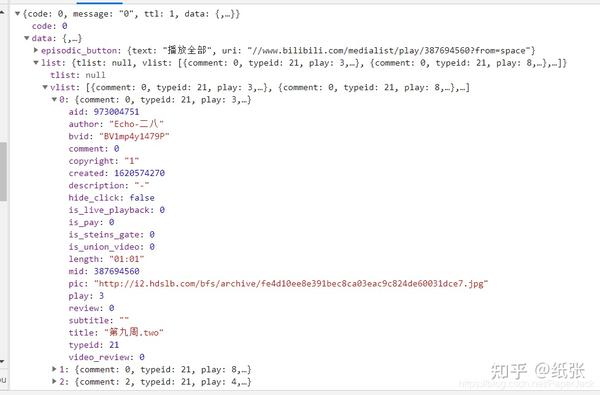

Demo1:爬取bilibili热点信息

from lxml import etree

import requests

# 要爬取的url,注意:在开发者工具中,这个url指的是第一个url

url = "https://www.bilibili.com/v/popular/rank/all"

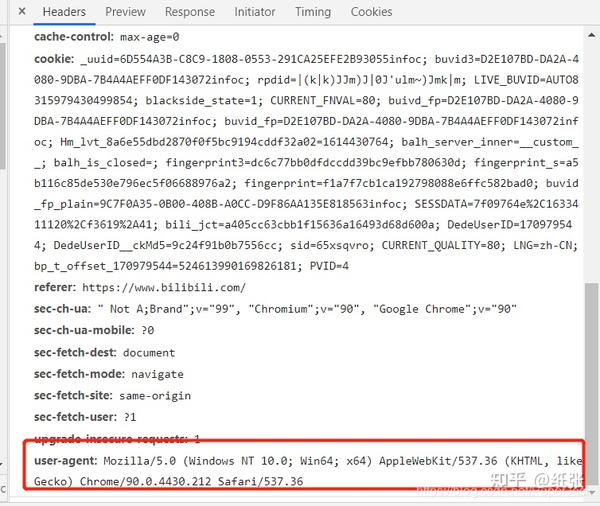

# 模仿浏览器的headers

headers = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.114 Safari/537.36"

}

# get请求,传入参数,返回结果集

resp = requests.get(url,headers=headers)

# 将结果集的文本转化为树的结构

tree = etree.HTML(resp.text)

# 定义列表存储所有数据

dli = []

# 遍历所有数据

for s in range(1,101):

li = []

#根据树的路径找到对应的数据集

num = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[1]/text()") # 获取热搜排序

name = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/a/text()")# 获取标题

url = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/a/@href")#获取链接

look = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/div[1]/span[1]/text()")# 获取播放量

say = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/div[1]/span[2]/text()") # 获取评论量

up = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/div[1]/a/span/text()") # 获取up主

score = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/div[2]/div/text()") # 获取综合得分

#获取数据集中的元素

li.append(num[0])

li.append(name[0])

li.append(url[0])

li.append(look[0])

li.append(say[0])

li.append(up[0])

li.append(score[0])

dli.append(li)

# 打印数据

for dd in dli:

print(dd)

运行结果如下:(本例爬取的数据还需要进一步清理,可以参考python中处理字符串的replace方法)

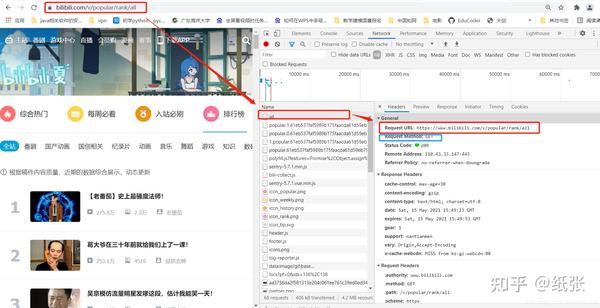

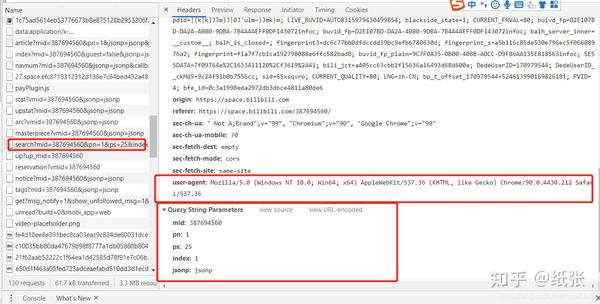

2.2. 数据通过其他 URL 返回

Demo2:爬取bilibili指定用户的首页信息

# 导入requests第三方库,导入报错则需要安装该库

import requests

# 要爬取的url,注意:在开发者工具中这个时候是要找数据对应的url,而不是第一个url

url = "https://api.bilibili.com/x/space/arc/search"

# 模仿浏览器的headers

headers = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.114 Safari/537.36"

}

# 需要的参数

params = {

"mid": 387694560,

"pn": 1,

"ps": 25,

"index": 1,

"jsonp": "jsonp"

}

# 调用get方法,传入参数,返回结果集

resp = requests.get(url,headers=headers,params=params)

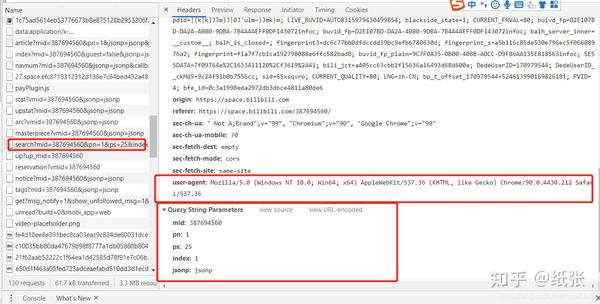

# 将结果以转化成js格式

js = resp.json()

# 获取js中我们需要的数据集

infos = js['data']['list']['vlist']

# 以下代码为遍历数据

bli = []

for info in infos:

li = []

author = info['author']

bvid = info['bvid']

pic = info['pic']

title = info['title']

li.append(author)

li.append(bvid)

li.append(pic)

li.append(title)

bli.append(li)

# 输出完整数据

for ll in bli:

print(ll)

操作结果如下:

3. 代码分析3.1. 数据在目标URL

上面代码中的URL、headers和xpath匹配都是直接在开发者工具中复制的。

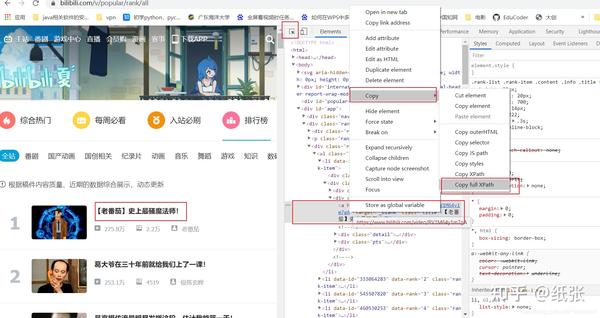

注意:复制xpath的全路径:先通过开发者工具的箭头工具选择你需要的元素,在元素中右键该元素,复制即可。

注意:复制的xpath的完整路径需要进一步调整

获取标签的文本,在路径后添加/text(),获取元素标签的标签值,路径后添加/@attribute name。如果要获取多个相同的数据(例如必须获取Ranks 1, 2...)。这时候就可以在xpath中把字符串拼接起来,然后用一个循环来一一遍历。

3.2. 数据通过其他 URL 返回

这种类型的 URL 不是第一个,而是我们用数据找到的 URL。其他规则与上一条基本相同。但是在获取数据的地方,现在是解析js数据。读者可以看图对比上面的代码,就知道如何解析js数据了。

3.3 总结 上面列出的两种方法只是在使用python爬虫时遇到的最常见的方法。这并不意味着所有情况都适合。这两种情况只适用于正常情况下,但实际业务往往包括处理。Cookie、处理防盗链、多线程、多进程等,但由于本文仅针对入门级,所以本文不收录这部分内容。网上能看到的很多请求都是get和post。所以对于这两个,我们在抓取网页的时候,要注意用的是什么方法,不要搞错,检查get方法是否需要params参数,post方法是否需要form参数。4. 原理说明

其实网页中的很多数据并不是直接放入HTML中的,有些是通过js来渲染的。因此,根据这两点的不同,我们可以指定两种不同的解决方案。当数据放在HTML中时,我们使用xpath来解析数据;数据以js格式响应时,直接按照层级关系获取。

5. 项目地址

/zhizhangxuezhang/CrawlerEntryCodeExample 查看全部

怎样抓取网页数据(

开发者工具的操作不多展开(一)——PS)

PS:这里就不多展开开发者工具的操作了。

1.2.2. 简单的想法

很多时候我们会发现爬虫有时候不是那么流畅,有时候需要添加很多细节,但是总体思路不会离开这三步。显然这还远远不够,所以还需要更详细的步骤

1.2.3. 详细思路

打开一个特定的网页,查看该网页的源代码,找到(CTRL+F)你要查找的数据是否在该网页中。

2.1. 如果是,此时打开开发者模式,点击网络,刷新。这时候你会发现,你需要的数据恰好在第一个 URL 处返回。如下

最后写代码爬取网页并使用xpath解析

2.2. 如果没有,此时需要打开开发者模式,点击网络,刷新。这时候你会发现不能像2.1那样在第一个网站中返回数据。这时,数据隐藏在其他js等文件中。(这里需要一点前端开发的基础)。我们需要找出数据存储在哪个环节,搜索方式往往是人工和经验过滤,可以先过滤XHR数据。如图:

通过上面的案例,我们过滤到了百度首页的“百度”这个词,如图:

最后写代码爬取网页,使用json解析(大多数情况下)

1.3. 需要安装的第三方库

请求:获取网络数据

lxml:解析html等格式文件中的数据2.代码示例2.1.数据在目标URL中

Demo1:爬取bilibili热点信息

from lxml import etree

import requests

# 要爬取的url,注意:在开发者工具中,这个url指的是第一个url

url = "https://www.bilibili.com/v/popular/rank/all"

# 模仿浏览器的headers

headers = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.114 Safari/537.36"

}

# get请求,传入参数,返回结果集

resp = requests.get(url,headers=headers)

# 将结果集的文本转化为树的结构

tree = etree.HTML(resp.text)

# 定义列表存储所有数据

dli = []

# 遍历所有数据

for s in range(1,101):

li = []

#根据树的路径找到对应的数据集

num = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[1]/text()") # 获取热搜排序

name = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/a/text()")# 获取标题

url = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/a/@href")#获取链接

look = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/div[1]/span[1]/text()")# 获取播放量

say = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/div[1]/span[2]/text()") # 获取评论量

up = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/div[1]/a/span/text()") # 获取up主

score = tree.xpath("/html/body/div[3]/div[2]/div[2]/ul/li["+str(s)+"]/div[2]/div[2]/div[2]/div/text()") # 获取综合得分

#获取数据集中的元素

li.append(num[0])

li.append(name[0])

li.append(url[0])

li.append(look[0])

li.append(say[0])

li.append(up[0])

li.append(score[0])

dli.append(li)

# 打印数据

for dd in dli:

print(dd)

运行结果如下:(本例爬取的数据还需要进一步清理,可以参考python中处理字符串的replace方法)

2.2. 数据通过其他 URL 返回

Demo2:爬取bilibili指定用户的首页信息

# 导入requests第三方库,导入报错则需要安装该库

import requests

# 要爬取的url,注意:在开发者工具中这个时候是要找数据对应的url,而不是第一个url

url = "https://api.bilibili.com/x/space/arc/search"

# 模仿浏览器的headers

headers = {

"user-agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.114 Safari/537.36"

}

# 需要的参数

params = {

"mid": 387694560,

"pn": 1,

"ps": 25,

"index": 1,

"jsonp": "jsonp"

}

# 调用get方法,传入参数,返回结果集

resp = requests.get(url,headers=headers,params=params)

# 将结果以转化成js格式

js = resp.json()

# 获取js中我们需要的数据集

infos = js['data']['list']['vlist']

# 以下代码为遍历数据

bli = []

for info in infos:

li = []

author = info['author']

bvid = info['bvid']

pic = info['pic']

title = info['title']

li.append(author)

li.append(bvid)

li.append(pic)

li.append(title)

bli.append(li)

# 输出完整数据

for ll in bli:

print(ll)

操作结果如下:

3. 代码分析3.1. 数据在目标URL

上面代码中的URL、headers和xpath匹配都是直接在开发者工具中复制的。

注意:复制xpath的全路径:先通过开发者工具的箭头工具选择你需要的元素,在元素中右键该元素,复制即可。

注意:复制的xpath的完整路径需要进一步调整

获取标签的文本,在路径后添加/text(),获取元素标签的标签值,路径后添加/@attribute name。如果要获取多个相同的数据(例如必须获取Ranks 1, 2...)。这时候就可以在xpath中把字符串拼接起来,然后用一个循环来一一遍历。

3.2. 数据通过其他 URL 返回

这种类型的 URL 不是第一个,而是我们用数据找到的 URL。其他规则与上一条基本相同。但是在获取数据的地方,现在是解析js数据。读者可以看图对比上面的代码,就知道如何解析js数据了。

3.3 总结 上面列出的两种方法只是在使用python爬虫时遇到的最常见的方法。这并不意味着所有情况都适合。这两种情况只适用于正常情况下,但实际业务往往包括处理。Cookie、处理防盗链、多线程、多进程等,但由于本文仅针对入门级,所以本文不收录这部分内容。网上能看到的很多请求都是get和post。所以对于这两个,我们在抓取网页的时候,要注意用的是什么方法,不要搞错,检查get方法是否需要params参数,post方法是否需要form参数。4. 原理说明

其实网页中的很多数据并不是直接放入HTML中的,有些是通过js来渲染的。因此,根据这两点的不同,我们可以指定两种不同的解决方案。当数据放在HTML中时,我们使用xpath来解析数据;数据以js格式响应时,直接按照层级关系获取。

5. 项目地址

/zhizhangxuezhang/CrawlerEntryCodeExample

怎样抓取网页数据(《2016年度目标制定评估模板》中2721家上市公司)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-09-22 23:11

数据分析师必须具有技能

我们会发现,在进行数据分析时,互联网上可以从互联网上获得大多数参考数据。互联网上的原创数据往往并不令人满意,很难满足我们的个性化需求,因此我们需要根据实际目标抓住,组织和分析。我们可以说互联网数据捕获和组织,是每个数据分析师的必要技能。

例如,在“2016年目标发展评估模板”中,为期5年的业务,业务成本,272家上市公司的净利润数据,是通过Excel的“网站”来捕获,组织和组织和组织它们特征。最终分析。

让我们谈谈如何使用Excel捕获,完成和分析:

1

数据捕获

我想抓住互联网数据,首先我们必须确定哪个网站的数据接近我们的需求,选择合适的网站将使我们发生了一半。然后我们可以采取以下功能,获取页面数据:

(注意:不同版本,函数“按钮”位置可能略有不同,此遗留程序不适用于所有网页,这与页面的写入语言和方法相关。)

如果要抓住多个页面数据,则需要通过调试VBA代码来实现它,并且可以通过网络理解特定方法,并且不会在此处再次描述。

2

数据完成

从网站,原创数据,经常格式不是我们想要的,我们必须完成数据。例如:“2016年度目标评估模板”我们抓住的数据格式如下,这不是我们想要的格式。因为数据量,需要VBA。通过VBA代码,我们将继续写入新表,最后形成模板所需的业务数据。 (可以通过网络学习特定方法)

3

数据分析

我们可以掌握数据,无论直接使用三个七十一,必须确定数据的可用性和逻辑。例如,模板数据在使用期间遇到以下类似的情况:

假设上表7家公司是一个小型行业,公司有重大变化,使性能如此成长。如果我们使用平均增长率,或者2015年常用,计算总成本,计算结果完全围绕A,这是表示这一小型行业的增长不合理。中位数的增长更接近实际情况。因此,我们终于选择了业界的消费增长率,因为您开发了2016年年度目标行业参考。这里,Excel的普及是流行的,并且Excel计算的功能格式是:

中位数(Medits数组),输出结果是阵列的中值。

我们通过“2016目标目标模板”讨论有关互联网数据捕获,整理和分析的问题。有很多方法可以爬网数据。这不仅是一种方式。如果技术在互联网数据上崩溃,您会在数据分析时使您不利,并且数据中的海洋中的市场超过了这些数据。

大约2016年目标评估模板更详细的信息,您可以了解参考,或观看以下视频:

2016目标评估模板[值版] 查看全部

怎样抓取网页数据(《2016年度目标制定评估模板》中2721家上市公司)

数据分析师必须具有技能

我们会发现,在进行数据分析时,互联网上可以从互联网上获得大多数参考数据。互联网上的原创数据往往并不令人满意,很难满足我们的个性化需求,因此我们需要根据实际目标抓住,组织和分析。我们可以说互联网数据捕获和组织,是每个数据分析师的必要技能。

例如,在“2016年目标发展评估模板”中,为期5年的业务,业务成本,272家上市公司的净利润数据,是通过Excel的“网站”来捕获,组织和组织和组织它们特征。最终分析。

让我们谈谈如何使用Excel捕获,完成和分析:

1

数据捕获

我想抓住互联网数据,首先我们必须确定哪个网站的数据接近我们的需求,选择合适的网站将使我们发生了一半。然后我们可以采取以下功能,获取页面数据:

(注意:不同版本,函数“按钮”位置可能略有不同,此遗留程序不适用于所有网页,这与页面的写入语言和方法相关。)

如果要抓住多个页面数据,则需要通过调试VBA代码来实现它,并且可以通过网络理解特定方法,并且不会在此处再次描述。

2

数据完成

从网站,原创数据,经常格式不是我们想要的,我们必须完成数据。例如:“2016年度目标评估模板”我们抓住的数据格式如下,这不是我们想要的格式。因为数据量,需要VBA。通过VBA代码,我们将继续写入新表,最后形成模板所需的业务数据。 (可以通过网络学习特定方法)

3

数据分析

我们可以掌握数据,无论直接使用三个七十一,必须确定数据的可用性和逻辑。例如,模板数据在使用期间遇到以下类似的情况:

假设上表7家公司是一个小型行业,公司有重大变化,使性能如此成长。如果我们使用平均增长率,或者2015年常用,计算总成本,计算结果完全围绕A,这是表示这一小型行业的增长不合理。中位数的增长更接近实际情况。因此,我们终于选择了业界的消费增长率,因为您开发了2016年年度目标行业参考。这里,Excel的普及是流行的,并且Excel计算的功能格式是:

中位数(Medits数组),输出结果是阵列的中值。

我们通过“2016目标目标模板”讨论有关互联网数据捕获,整理和分析的问题。有很多方法可以爬网数据。这不仅是一种方式。如果技术在互联网数据上崩溃,您会在数据分析时使您不利,并且数据中的海洋中的市场超过了这些数据。

大约2016年目标评估模板更详细的信息,您可以了解参考,或观看以下视频:

2016目标评估模板[值版]

怎样抓取网页数据(linux类服务器的话:可以用crontab来部署自动化任务)

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-09-21 21:12

对于Linux服务器:

您可以使用crontab部署自动化任务。请自己检查一下信息

Python xxx.py(如果未配置环境变量,则遵循Python的绝对路径,例如/usr/bin/Python xxx.File)

对于Windows服务器:

您可以使用windows提供的管理工具中的任务计划程序来部署自动执行

将命令写入bat文件,该文件也是Python xxxx.py(如果未配置环境变量,则遵循Python的绝对路径,例如C:/python27/Python XXX.file)

对于这两种部署,您可以根据自己的需要设置周期,例如每天的时间、每周的时间等等

如何使用Python爬虫从网页中批量获取所需信息:Python是一种广泛使用的脚本语言。谷歌的网页是用Python编写的。Python在生物信息、统计、网页制作和计算等领域具有强大的功能。Python与Java、R和Perl等其他脚本语言相同,您可以直接在命令行上运行脚本

如何使用Python爬虫抓取web内容?-:首先,您需要安装requests和beautiful soup 4,然后执行以下代码。62232425262728293031323334来自BS4进口美容汤的进口请求

如何使用最简单的Python爬虫程序采集来完成网站-:Python实现了前面文章中的“Wikipedia六度分离理论”“作为一个基本的爬虫程序,我们已经在网站@上实现了从一个链接到另一个链接的随机链接,但是如果我们需要系统地按目录对整个网站@进行分类,或者在网站@上搜索每个页面,我们应该怎么做?”采集...

如何使用Python抓取简单网页-:推荐:Python spider crawler教程(二):Ajax和HTTP)--因为Ajax实际上是通过HTTP传输数据的,所以我们可以通过chrome developer工具找到真正的请求,并直接开始捕获真正的请求以获取数据。Ajax通常通过XMLHttpRequest对象接口发送请求,XMLHttpRequest通常缩写为XHR

如何使用Python抓取网页并实现一些提交操作?:这可以是百度:Python爬虫入门。然后会有一些视频或在线教程,教你如何抓取网页数据并通过post提交操作

如何使用Python抓取网页内容:1.首先,您应该能够读取文件。2.然后使用正则表达式匹配要获取的内容

如何使用Python从网页中获取数据:最简单的方法是使用urllib,python2.X和python3.X的用法不同于python2.X为例:导入urllib HTML=urllib。打开(URL)文本=HTML。Read()对于更复杂的内容,您可以使用请求库来支持各种请求类型、cookie、标题等。对于更复杂的内容,您可以使用selenium来捕获JavaScript生成的文本

如何用Python制作一个简单的web爬虫程序-:建议使用requests+Beauty soup框架来编写爬虫程序。Requests用于发送各种请求,Beauty soup用于解析页面内容和提取数据。当然,python也有一些现成的爬虫库,如scratch、pyspider等

如何使用Python爬虫来抓取和加载更多网页:我自己还没有尝试过。我只是将crawler框架pyspider与phantom JS结合使用,这样我就可以在Python中嵌入一些JS代码,实现点击、下拉等操作

如何使用Python抓取网页上的表信息-:让我们谈谈背景。当时,我想研究蛋白质和小分子复合物的空间三维结构的一些规律。首先,我必须有数据。这些数据来自哪里?也就是说,从一个数据库下载它,该数据库涵盖了所有分析过三维结构的蛋白质小分子复合物。在这个时候,一个接一个的手动操作显然是不可能的 查看全部

怎样抓取网页数据(linux类服务器的话:可以用crontab来部署自动化任务)

对于Linux服务器:

您可以使用crontab部署自动化任务。请自己检查一下信息

Python xxx.py(如果未配置环境变量,则遵循Python的绝对路径,例如/usr/bin/Python xxx.File)

对于Windows服务器:

您可以使用windows提供的管理工具中的任务计划程序来部署自动执行

将命令写入bat文件,该文件也是Python xxxx.py(如果未配置环境变量,则遵循Python的绝对路径,例如C:/python27/Python XXX.file)

对于这两种部署,您可以根据自己的需要设置周期,例如每天的时间、每周的时间等等

如何使用Python爬虫从网页中批量获取所需信息:Python是一种广泛使用的脚本语言。谷歌的网页是用Python编写的。Python在生物信息、统计、网页制作和计算等领域具有强大的功能。Python与Java、R和Perl等其他脚本语言相同,您可以直接在命令行上运行脚本

如何使用Python爬虫抓取web内容?-:首先,您需要安装requests和beautiful soup 4,然后执行以下代码。62232425262728293031323334来自BS4进口美容汤的进口请求

如何使用最简单的Python爬虫程序采集来完成网站-:Python实现了前面文章中的“Wikipedia六度分离理论”“作为一个基本的爬虫程序,我们已经在网站@上实现了从一个链接到另一个链接的随机链接,但是如果我们需要系统地按目录对整个网站@进行分类,或者在网站@上搜索每个页面,我们应该怎么做?”采集...

如何使用Python抓取简单网页-:推荐:Python spider crawler教程(二):Ajax和HTTP)--因为Ajax实际上是通过HTTP传输数据的,所以我们可以通过chrome developer工具找到真正的请求,并直接开始捕获真正的请求以获取数据。Ajax通常通过XMLHttpRequest对象接口发送请求,XMLHttpRequest通常缩写为XHR

如何使用Python抓取网页并实现一些提交操作?:这可以是百度:Python爬虫入门。然后会有一些视频或在线教程,教你如何抓取网页数据并通过post提交操作

如何使用Python抓取网页内容:1.首先,您应该能够读取文件。2.然后使用正则表达式匹配要获取的内容

如何使用Python从网页中获取数据:最简单的方法是使用urllib,python2.X和python3.X的用法不同于python2.X为例:导入urllib HTML=urllib。打开(URL)文本=HTML。Read()对于更复杂的内容,您可以使用请求库来支持各种请求类型、cookie、标题等。对于更复杂的内容,您可以使用selenium来捕获JavaScript生成的文本

如何用Python制作一个简单的web爬虫程序-:建议使用requests+Beauty soup框架来编写爬虫程序。Requests用于发送各种请求,Beauty soup用于解析页面内容和提取数据。当然,python也有一些现成的爬虫库,如scratch、pyspider等

如何使用Python爬虫来抓取和加载更多网页:我自己还没有尝试过。我只是将crawler框架pyspider与phantom JS结合使用,这样我就可以在Python中嵌入一些JS代码,实现点击、下拉等操作

如何使用Python抓取网页上的表信息-:让我们谈谈背景。当时,我想研究蛋白质和小分子复合物的空间三维结构的一些规律。首先,我必须有数据。这些数据来自哪里?也就是说,从一个数据库下载它,该数据库涵盖了所有分析过三维结构的蛋白质小分子复合物。在这个时候,一个接一个的手动操作显然是不可能的

怎样抓取网页数据(模拟真实浏览器发送请求,获取服务器响应的文件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2021-09-21 21:11

b) 处理后的请求可以模拟浏览器发送请求并获取服务器响应的文件

3、parse服务器响应内容

a) re、xpath、beautifulSoup4(bs4)、jsonpath、pyquery

b) 使用描述性语言为需要提取的数据定义匹配规则。如果符合规则,则数据将匹配

4、如何处理采集动态HTML和验证代码

a) 通用动态页面采集,selenium+phantom JS(无接口):模拟真实浏览器加载JS和Ajax非静态页面数据

b) Tesseract:机器学习库,机器图像识别系统,可以处理简单的验证代码。复杂的验证代码可以手动输入并在平台上打印

5、scrapy框架(scrapy,pyspider)

高定制和高性能(异步网络框架扭曲),因此数据下载速度特别快。它提供数据存储、数据下载、提取规则等组件

6、分布式策略:

a) Scratch redis在Scratch的基础上增加了一组以redis数据库为核心的组件

b) 功能:主要在redis中执行指纹重复数据消除、请求分配和临时数据存储

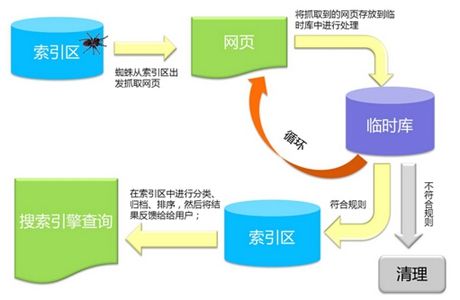

7、爬行动物,反爬行动物,反爬行动物斗争:

a) 爬虫最头疼的不是复杂的页面,而是它背后的网站另一个人

反爬虫:用户代理、代理、验证码、动态数据加载、加密数据

反爬虫主要取决于数据值。做反爬虫值得吗

主要考虑如下:机器成本+人工成本的数据值不可反转。一般来说,IP密封已经结束

通用爬虫焦点爬虫

1、universal crawler:搜索引擎的爬虫系统

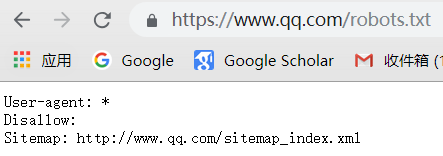

-1目标:尽可能下载互联网上的所有网页,将其放入本地服务器进行备份,然后对这些网页进行相应处理(提取关键字和删除广告),最后为用户提供登录的借口

-二,。捕获过程:

a。最好选择一些现有URL并将它们放入要爬网的队列中

b。从队列中获取这些URL,然后解析DNS以获取主机IP,然后从IP对应的服务器下载HTML页面,保存到搜索引擎对应的服务器,然后将爬网URL放入爬网队列

c。分析这些网页的内容,找出网页中的其他URL连接,并继续执行第二部分,直到爬虫条件结束

-3、搜索引擎如何获得新的URL网站

1、主动向搜索引擎提交网站(百度连接提交)

2、在其他网站中设置外链:

3、搜索引擎将与DNS服务提供商合作,快速收录new网站

DNS:一种将域名解析为IP地址的技术

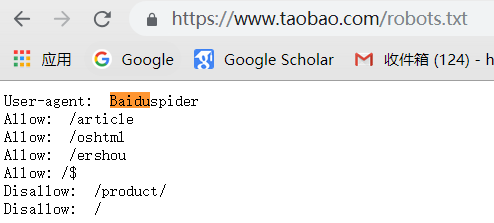

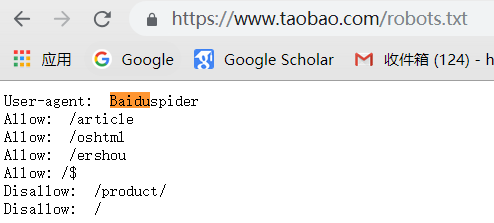

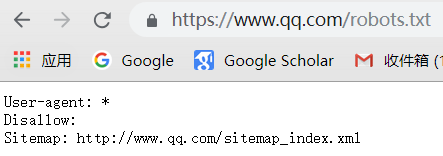

-4、universal Crawler并不是所有可以爬行的东西,它们还需要遵守规则

Robots协议:该协议将指定普通爬虫可以爬网网页的权限

Robots.txt只是一个建议。并不是所有的爬虫都跟随它。只有大型搜索引擎爬虫才需要跟随它

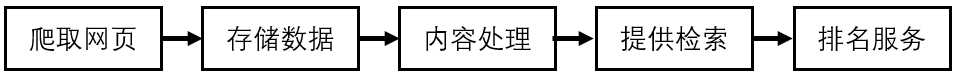

-5通用爬虫工作流:抓取网页、存储数据、内容处理、提供索引/排名服务

-6、搜索引擎排名:

a。PageRank:根据网站流量(点击率/浏览量/人气),流量越高

b。竞争排名:谁给的钱越多,排名就越高

-7、universal crawler的缺点:

1、只能提供文本相关内容(HTML\word\PDF)等,但不能提供多媒体和二进制

2、为不同背景的人提供不同的搜索结果

3、无法理解人类语义检索

要解决此问题,将出现焦点爬虫:

聚焦爬虫:由爬虫程序员为特定内容编写的爬虫

面向主题的爬虫、面向需求的爬虫:它将对特定内容的信息进行爬虫,并确保信息和需求尽可能相关 查看全部

怎样抓取网页数据(模拟真实浏览器发送请求,获取服务器响应的文件)

b) 处理后的请求可以模拟浏览器发送请求并获取服务器响应的文件

3、parse服务器响应内容

a) re、xpath、beautifulSoup4(bs4)、jsonpath、pyquery

b) 使用描述性语言为需要提取的数据定义匹配规则。如果符合规则,则数据将匹配

4、如何处理采集动态HTML和验证代码

a) 通用动态页面采集,selenium+phantom JS(无接口):模拟真实浏览器加载JS和Ajax非静态页面数据

b) Tesseract:机器学习库,机器图像识别系统,可以处理简单的验证代码。复杂的验证代码可以手动输入并在平台上打印

5、scrapy框架(scrapy,pyspider)

高定制和高性能(异步网络框架扭曲),因此数据下载速度特别快。它提供数据存储、数据下载、提取规则等组件

6、分布式策略:

a) Scratch redis在Scratch的基础上增加了一组以redis数据库为核心的组件

b) 功能:主要在redis中执行指纹重复数据消除、请求分配和临时数据存储

7、爬行动物,反爬行动物,反爬行动物斗争:

a) 爬虫最头疼的不是复杂的页面,而是它背后的网站另一个人

反爬虫:用户代理、代理、验证码、动态数据加载、加密数据

反爬虫主要取决于数据值。做反爬虫值得吗

主要考虑如下:机器成本+人工成本的数据值不可反转。一般来说,IP密封已经结束

通用爬虫焦点爬虫

1、universal crawler:搜索引擎的爬虫系统

-1目标:尽可能下载互联网上的所有网页,将其放入本地服务器进行备份,然后对这些网页进行相应处理(提取关键字和删除广告),最后为用户提供登录的借口

-二,。捕获过程:

a。最好选择一些现有URL并将它们放入要爬网的队列中

b。从队列中获取这些URL,然后解析DNS以获取主机IP,然后从IP对应的服务器下载HTML页面,保存到搜索引擎对应的服务器,然后将爬网URL放入爬网队列

c。分析这些网页的内容,找出网页中的其他URL连接,并继续执行第二部分,直到爬虫条件结束

-3、搜索引擎如何获得新的URL网站

1、主动向搜索引擎提交网站(百度连接提交)

2、在其他网站中设置外链:

3、搜索引擎将与DNS服务提供商合作,快速收录new网站

DNS:一种将域名解析为IP地址的技术

-4、universal Crawler并不是所有可以爬行的东西,它们还需要遵守规则

Robots协议:该协议将指定普通爬虫可以爬网网页的权限

Robots.txt只是一个建议。并不是所有的爬虫都跟随它。只有大型搜索引擎爬虫才需要跟随它

-5通用爬虫工作流:抓取网页、存储数据、内容处理、提供索引/排名服务

-6、搜索引擎排名:

a。PageRank:根据网站流量(点击率/浏览量/人气),流量越高

b。竞争排名:谁给的钱越多,排名就越高

-7、universal crawler的缺点:

1、只能提供文本相关内容(HTML\word\PDF)等,但不能提供多媒体和二进制

2、为不同背景的人提供不同的搜索结果

3、无法理解人类语义检索

要解决此问题,将出现焦点爬虫:

聚焦爬虫:由爬虫程序员为特定内容编写的爬虫

面向主题的爬虫、面向需求的爬虫:它将对特定内容的信息进行爬虫,并确保信息和需求尽可能相关

怎样抓取网页数据(提取HTML页面内有用的数据:Python爬虫的优势)

网站优化 • 优采云 发表了文章 • 0 个评论 • 369 次浏览 • 2021-09-20 06:18

提取HTML页面内有用的数据:

a. 如果是需要的数据--保存

b. 如果有其他URL,继续执行第二步

4. Python爬虫的优势?

5. 学习路线

抓取HTML页面:

HTTP请求的处理:urllib, urlib2, requests

处理器的请求可以模拟浏览器发送请求,获取服务器响应的文件

解析服务器相应的内容:

re, xpath, BeautifulSoup(bs4), jsonpath, pyquery等

使用某种描述性语言来给我们需要提取的数据定义一个匹配规则,符合这个规则的数据就会被匹配

采集动态HTML,验证码的处理

通用动态页面采集:Selenium + PhantomJS:模拟真实浏览器加载JS

验证码处理:Tesseract机器学习库,机器图像识别系统

Scrapy框架:

高定制性,高性能(异步网络框架twisted)->数据下载快

提供了数据存储,数据下载,提取规则等组件

分布式策略:

scrapy redis:在scarpy基础上添加了以redis数据库为核心的一套组件,主要在redis做请求指纹去重、请求分配、数据临时存储

爬虫、反爬虫、反反爬虫之间的斗争:

User-Agent,代理,验证码,动态数据加载,加密数据

6. 爬虫的分类

6.1 通用爬虫:

1.定义:搜索引擎用的爬虫系统

2.目标:把所有互联网的网页爬取下来,放到本地服务器形成备份,在对这些网页做相关处理(提取关键字,去除广告),最后提供一个用户可以访问的借口

3.抓取流程:

a) 首先选取一部分已有的URL, 把这些URL放到带爬取队列中

b) 从队列中取出来URL,然后解析NDS得到主机IP,然后去这个IP对应的服务器里下载HTML页面,保存到搜索引擎的本地服务器里,之后把爬过的URL放入已爬取队列

c) 分析网页内容,找出网页里其他的URL连接,继续执行第二步,直到爬取结束

4.搜索引擎如何获取一个新网站的URL:

主动向搜索引擎提交网址:

在其他网站设置网站的外链: 其他网站上面的友情链接

搜索引擎会和DNS服务商进行合作,可以快速收录新网站

5.通用爬虫注意事项

通用爬虫并不是万物皆可以爬,它必须遵守规则:

Robots协议:协议会指明通用爬虫可以爬取网页的权限

我们可以访问不同网页的Robots权限

6.通用爬虫通用流程:

7.通用爬虫缺点

只能提供和文本相关的内容(HTML,WORD,PDF)等,不能提供多媒体文件(msic,picture, video)及其他二进制文件

提供结果千篇一律,不能针对不同背景领域的人听不同的搜索结果

不能理解人类语义的检索

聚焦爬虫的优势所在

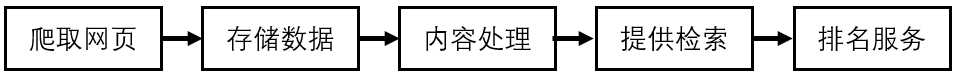

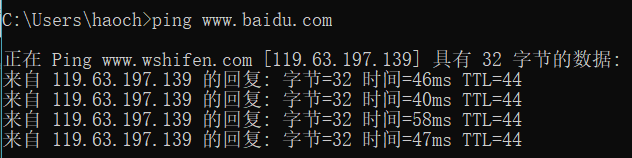

DNS域名解析成IP: 通过在命令框中输入ping ,得到服务器的IP

6.2 聚焦爬虫:

爬虫程序员写的针对某种内容的爬虫-> 面向主题爬虫,面向需要爬虫 查看全部

怎样抓取网页数据(提取HTML页面内有用的数据:Python爬虫的优势)

提取HTML页面内有用的数据:

a. 如果是需要的数据--保存

b. 如果有其他URL,继续执行第二步

4. Python爬虫的优势?

5. 学习路线

抓取HTML页面:

HTTP请求的处理:urllib, urlib2, requests

处理器的请求可以模拟浏览器发送请求,获取服务器响应的文件

解析服务器相应的内容:

re, xpath, BeautifulSoup(bs4), jsonpath, pyquery等

使用某种描述性语言来给我们需要提取的数据定义一个匹配规则,符合这个规则的数据就会被匹配

采集动态HTML,验证码的处理

通用动态页面采集:Selenium + PhantomJS:模拟真实浏览器加载JS

验证码处理:Tesseract机器学习库,机器图像识别系统

Scrapy框架:

高定制性,高性能(异步网络框架twisted)->数据下载快

提供了数据存储,数据下载,提取规则等组件

分布式策略:

scrapy redis:在scarpy基础上添加了以redis数据库为核心的一套组件,主要在redis做请求指纹去重、请求分配、数据临时存储

爬虫、反爬虫、反反爬虫之间的斗争:

User-Agent,代理,验证码,动态数据加载,加密数据

6. 爬虫的分类

6.1 通用爬虫:

1.定义:搜索引擎用的爬虫系统

2.目标:把所有互联网的网页爬取下来,放到本地服务器形成备份,在对这些网页做相关处理(提取关键字,去除广告),最后提供一个用户可以访问的借口

3.抓取流程:

a) 首先选取一部分已有的URL, 把这些URL放到带爬取队列中

b) 从队列中取出来URL,然后解析NDS得到主机IP,然后去这个IP对应的服务器里下载HTML页面,保存到搜索引擎的本地服务器里,之后把爬过的URL放入已爬取队列

c) 分析网页内容,找出网页里其他的URL连接,继续执行第二步,直到爬取结束

4.搜索引擎如何获取一个新网站的URL:

主动向搜索引擎提交网址:

在其他网站设置网站的外链: 其他网站上面的友情链接

搜索引擎会和DNS服务商进行合作,可以快速收录新网站

5.通用爬虫注意事项

通用爬虫并不是万物皆可以爬,它必须遵守规则:

Robots协议:协议会指明通用爬虫可以爬取网页的权限

我们可以访问不同网页的Robots权限

6.通用爬虫通用流程:

7.通用爬虫缺点

只能提供和文本相关的内容(HTML,WORD,PDF)等,不能提供多媒体文件(msic,picture, video)及其他二进制文件

提供结果千篇一律,不能针对不同背景领域的人听不同的搜索结果

不能理解人类语义的检索

聚焦爬虫的优势所在

DNS域名解析成IP: 通过在命令框中输入ping ,得到服务器的IP

6.2 聚焦爬虫:

爬虫程序员写的针对某种内容的爬虫-> 面向主题爬虫,面向需要爬虫

怎样抓取网页数据( 搜索引擎蜘蛛能很好地识别HTML代码模拟蜘蛛爬行)

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-09-17 07:20

搜索引擎蜘蛛能很好地识别HTML代码模拟蜘蛛爬行)

搜索引擎爬行器爬网网站和抓取数据的规则

以下四点提供了搜索引擎爬行器的爬行规则供参考:

1、SearchEngine爬行器应该能够看到链接文本

这是搜索引擎爬行器在爬行时可以检索的文本。如果文本或链接是通过JavaScript调用的,则爬行器无法检索它。主内容在页面文本内容中的位置越高,越有利。例如,产品名称在页面上的位置越高,产品关键词在页面上的排名就越好

2、SearchEngine爬行器可以抓取nofollow未处理的链接

此项列出搜索引擎爬行器可以检索链接,爬行器可以通过这些链接访问网站其他页面。前端链接越高,被蜘蛛抓取的概率越大,被搜索引擎收录抓取的概率越高@

3、搜索引擎蜘蛛可以找到图片链接并阅读这些图片的含义

此页面主要显示搜索引擎spider和国际W3C标准化监视器检索到的图片。搜索引擎可以根据图片at=”“判断图片的类型、性质和主题,这对判断链接到图片的页面的主题有很大帮助,可以有效提高商品展示页面的搜索引擎排名。根据W3C标准,页面上的所有图片必须添加ALT=”“picture comments网站Logo使用网站名称和简短描述,将产品名称用于产品图片,并将页面框架图片留空

4、SearchEngine爬行器可以很好地识别HTML代码

当模拟搜索引擎蜘蛛爬行页面时,“最简单的代码->指过滤CSS和JavaScript后的代码”。可以看出,减少多余的代码空间(如空行、换行符和空格)非常重要 查看全部

怎样抓取网页数据(

搜索引擎蜘蛛能很好地识别HTML代码模拟蜘蛛爬行)

搜索引擎爬行器爬网网站和抓取数据的规则

以下四点提供了搜索引擎爬行器的爬行规则供参考:

1、SearchEngine爬行器应该能够看到链接文本

这是搜索引擎爬行器在爬行时可以检索的文本。如果文本或链接是通过JavaScript调用的,则爬行器无法检索它。主内容在页面文本内容中的位置越高,越有利。例如,产品名称在页面上的位置越高,产品关键词在页面上的排名就越好

2、SearchEngine爬行器可以抓取nofollow未处理的链接

此项列出搜索引擎爬行器可以检索链接,爬行器可以通过这些链接访问网站其他页面。前端链接越高,被蜘蛛抓取的概率越大,被搜索引擎收录抓取的概率越高@

3、搜索引擎蜘蛛可以找到图片链接并阅读这些图片的含义

此页面主要显示搜索引擎spider和国际W3C标准化监视器检索到的图片。搜索引擎可以根据图片at=”“判断图片的类型、性质和主题,这对判断链接到图片的页面的主题有很大帮助,可以有效提高商品展示页面的搜索引擎排名。根据W3C标准,页面上的所有图片必须添加ALT=”“picture comments网站Logo使用网站名称和简短描述,将产品名称用于产品图片,并将页面框架图片留空

4、SearchEngine爬行器可以很好地识别HTML代码

当模拟搜索引擎蜘蛛爬行页面时,“最简单的代码->指过滤CSS和JavaScript后的代码”。可以看出,减少多余的代码空间(如空行、换行符和空格)非常重要

怎样抓取网页数据(中如何获取并定位网页的信息的方法?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 149 次浏览 • 2021-09-17 07:17

写在前面:这部分梳理了爬虫爬行的基本思想,并给出了一些场景下的解决方案。但不幸的是,没有足够的时间添加代码。在今后仔细阅读正式文件后,我将继续填写这一部分

如何在爬虫中获取和定位网页信息

由于我们获取的网页类型不同,我们想要抓取的信息的定位方法也有很大的不同,但一般来说,我们想要抓取的网页可以分为静态和动态。下面介绍如何在不同情况下对这些信息进行爬网

不同类型的网页

根据获取网页的不同方式,可分为

为什么动态网页要区分这两个网络爬虫

我们获取网页信息的方法的核心实现是以最小的代价模拟正常用户请求网页时的行为,只有在获取信息后才能解析网页;让我们首先介绍一些获取网页信息的工具,然后根据不同类型的网页解释如何使用这些工具

工具2:使用JS引擎呈现已爬网的JS代码:工具3:模拟浏览并单击网页:

动态网页模拟请求方法

爬虫定位网页信息的方法

爬虫定位网络信息的方法有两种:匹配文本和构建树搜索;让我们根据以下两种方法详细介绍每种工具:

第二类:树形搜索。最后,我们经常使用更成熟的库:lxml、BS4、XQuery、xpoint:

最后,我们将根据不同类型的网页确定使用的工具:

动态网络参考

[1] 百科全书XML/item/XML%E8%A7%A3%E6%9E%90%E5%99%A8/2673664?fr=阿拉丁

[2] 百科全书DOM/item/%E6%96%87%E6%A1%A3%E5%AF%B9%E8%B1%A1%E6%A8%A1%E5%9E%8B/1033822?fromtitle=DOM&fromid=50288&fr=aladdin

[3] 知乎DOM/QUOTE/34219998

[4] XSL页面/style/XSL/

[5] 百科全书XPath/item/XPath

[6] XPath官方网站/TR/XPath/all/

[7] Libxml2官方网站/

[8] Libxlst tutorial/XSLT/tutorial/libxslttutorial.html

[9] Lxml官方网站Lxml.de/

[10] Html5lib官方网站Html5lib.readthedoc.io/en/latest/Html5lib.html#

[11] 几个概念的比较/问题/20097166

[12] BS与lxml/question/26494302的比较 查看全部

怎样抓取网页数据(中如何获取并定位网页的信息的方法?(图))

写在前面:这部分梳理了爬虫爬行的基本思想,并给出了一些场景下的解决方案。但不幸的是,没有足够的时间添加代码。在今后仔细阅读正式文件后,我将继续填写这一部分

如何在爬虫中获取和定位网页信息

由于我们获取的网页类型不同,我们想要抓取的信息的定位方法也有很大的不同,但一般来说,我们想要抓取的网页可以分为静态和动态。下面介绍如何在不同情况下对这些信息进行爬网

不同类型的网页

根据获取网页的不同方式,可分为

为什么动态网页要区分这两个网络爬虫

我们获取网页信息的方法的核心实现是以最小的代价模拟正常用户请求网页时的行为,只有在获取信息后才能解析网页;让我们首先介绍一些获取网页信息的工具,然后根据不同类型的网页解释如何使用这些工具

工具2:使用JS引擎呈现已爬网的JS代码:工具3:模拟浏览并单击网页:

动态网页模拟请求方法

爬虫定位网页信息的方法

爬虫定位网络信息的方法有两种:匹配文本和构建树搜索;让我们根据以下两种方法详细介绍每种工具:

第二类:树形搜索。最后,我们经常使用更成熟的库:lxml、BS4、XQuery、xpoint:

最后,我们将根据不同类型的网页确定使用的工具:

动态网络参考

[1] 百科全书XML/item/XML%E8%A7%A3%E6%9E%90%E5%99%A8/2673664?fr=阿拉丁

[2] 百科全书DOM/item/%E6%96%87%E6%A1%A3%E5%AF%B9%E8%B1%A1%E6%A8%A1%E5%9E%8B/1033822?fromtitle=DOM&fromid=50288&fr=aladdin

[3] 知乎DOM/QUOTE/34219998

[4] XSL页面/style/XSL/

[5] 百科全书XPath/item/XPath

[6] XPath官方网站/TR/XPath/all/

[7] Libxml2官方网站/

[8] Libxlst tutorial/XSLT/tutorial/libxslttutorial.html

[9] Lxml官方网站Lxml.de/

[10] Html5lib官方网站Html5lib.readthedoc.io/en/latest/Html5lib.html#

[11] 几个概念的比较/问题/20097166

[12] BS与lxml/question/26494302的比较

怎样抓取网页数据(如何提高百度蜘蛛抓取频次起重要影响,如何做好)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-09-15 17:11

3、robots协议:此文件是百度蜘蛛访问的第一个文件。它会告诉百度蜘蛛哪些页面可以爬网,哪些页面不能爬网

三、如何提高百度蜘蛛捕获频率

百度蜘蛛会按照一定的规则抓取网站但不能一视同仁。以下内容将对百度蜘蛛的爬行频率产生重要影响

@K23网站weight:权重越高,网站Baidu蜘蛛抓取的频率越高,抓取的深度也越深

2、网站更新频率:更新频率越高,出现的百度蜘蛛越多

3、网站内容质量:网站如果原创内容多,百度将提高捕获频率,质量高,可以解决用户问题

4、import links:链接是页面的入口。高质量的链接可以更好地引导百度蜘蛛进入并爬行

5、页面深度:页面是否在主页上有入口。如果主页上有入口,则可以更好地捕获并收录

6、capture frequency决定了网站将在数据库收录中构建多少页面。这些重要内容的站长应该到哪里去理解和修改呢?你可以去百度站长平台了解一下捕获频率的功能

四、在什么情况下百度蜘蛛会抓取失败和其他例外

有些网站网页内容质量高,用户访问正常,但百度蜘蛛无法捕获,这不仅会损失流量和用户,还会被百度视为网站不友好,导致网站功耗降低、分数降低、导入网站流量降低等问题

下面简要介绍一下百度蜘蛛抢夺的原因:

1、server连接异常:有两个异常。一个是网站不稳定,这使得百度蜘蛛无法抓取。另一个是百度蜘蛛已经无法连接到服务器。这时,你应该仔细检查

2、网络运营商例外:目前国内网络运营商分为电信和联通。如果百度蜘蛛无法通过其中一个访问你的网站,你最好联系网络运营商解决问题

3、无法解析IP,导致DNS异常:当百度蜘蛛无法解析您时网站IP查询时将出现DNS异常。您可以使用whois查询您自己网站IP能否解决。如果没有,请联系域名注册商

4、IP阻塞:IP阻塞是对IP的限制。此操作只能在特定情况下执行,如果您希望网站Baidu spider正常访问您的网站Baidu,最好不要执行此操作

5、dead chain:表示页面无效,无法提供有效信息。此时,你可以通过百度站长平台提交死链

通过以上信息,我们可以大致了解百度蜘蛛爬行的原理,收录是网站流量的保证,而百度蜘蛛爬行是收录流量的保证,所以网站只有符合百度蜘蛛爬行规则,才能获得更好的排名和流量

本文链接: 查看全部

怎样抓取网页数据(如何提高百度蜘蛛抓取频次起重要影响,如何做好)

3、robots协议:此文件是百度蜘蛛访问的第一个文件。它会告诉百度蜘蛛哪些页面可以爬网,哪些页面不能爬网

三、如何提高百度蜘蛛捕获频率

百度蜘蛛会按照一定的规则抓取网站但不能一视同仁。以下内容将对百度蜘蛛的爬行频率产生重要影响

@K23网站weight:权重越高,网站Baidu蜘蛛抓取的频率越高,抓取的深度也越深

2、网站更新频率:更新频率越高,出现的百度蜘蛛越多

3、网站内容质量:网站如果原创内容多,百度将提高捕获频率,质量高,可以解决用户问题

4、import links:链接是页面的入口。高质量的链接可以更好地引导百度蜘蛛进入并爬行

5、页面深度:页面是否在主页上有入口。如果主页上有入口,则可以更好地捕获并收录

6、capture frequency决定了网站将在数据库收录中构建多少页面。这些重要内容的站长应该到哪里去理解和修改呢?你可以去百度站长平台了解一下捕获频率的功能

四、在什么情况下百度蜘蛛会抓取失败和其他例外

有些网站网页内容质量高,用户访问正常,但百度蜘蛛无法捕获,这不仅会损失流量和用户,还会被百度视为网站不友好,导致网站功耗降低、分数降低、导入网站流量降低等问题

下面简要介绍一下百度蜘蛛抢夺的原因:

1、server连接异常:有两个异常。一个是网站不稳定,这使得百度蜘蛛无法抓取。另一个是百度蜘蛛已经无法连接到服务器。这时,你应该仔细检查

2、网络运营商例外:目前国内网络运营商分为电信和联通。如果百度蜘蛛无法通过其中一个访问你的网站,你最好联系网络运营商解决问题

3、无法解析IP,导致DNS异常:当百度蜘蛛无法解析您时网站IP查询时将出现DNS异常。您可以使用whois查询您自己网站IP能否解决。如果没有,请联系域名注册商

4、IP阻塞:IP阻塞是对IP的限制。此操作只能在特定情况下执行,如果您希望网站Baidu spider正常访问您的网站Baidu,最好不要执行此操作

5、dead chain:表示页面无效,无法提供有效信息。此时,你可以通过百度站长平台提交死链

通过以上信息,我们可以大致了解百度蜘蛛爬行的原理,收录是网站流量的保证,而百度蜘蛛爬行是收录流量的保证,所以网站只有符合百度蜘蛛爬行规则,才能获得更好的排名和流量

本文链接:

怎样抓取网页数据(怎样抓取网页数据下载数据的知识-access统计数据知识)

网站优化 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-09-13 20:01

怎样抓取网页数据下载数据的知识我们之前也讲过,比如:downloadmyanimateddata看完这个教程,记得自己动手去查看、下载数据哦!access统计数据知识我们介绍完了,回过头来重复一下access统计数据的内容:access统计数据类型数据发布的最小要求列表数据发布的最大要求单机数据库创建help资料,创建服务器环境publicmesh创建子账号、子账号密码及密钥/注册新建、删除子账号注册使用environment/web/mesh;/***创建environment/web/mesh;*/。/***注册新的mesh服务器*/。access[global]="new";。

我是学生,我没有说这样没有用啊!你为什么不问学校为什么不发workfromhome?简单直接,

我觉得我们学校有这么个数据发布平台就挺好。

这问题很难,我本人学校已经实现了。

现在上个网站就查一下往期的报表了,

我们只发布数据(没有数据的可以寄在本专业网站,我们只是给本专业同学提供报表查询,校外学生不接受)下载是没有的,课程展示可以用虚拟机下载。研究生我还是给点意见吧。不然你会想不到这样我们也实现了,虽然下载才几十个g。 查看全部

怎样抓取网页数据(怎样抓取网页数据下载数据的知识-access统计数据知识)

怎样抓取网页数据下载数据的知识我们之前也讲过,比如:downloadmyanimateddata看完这个教程,记得自己动手去查看、下载数据哦!access统计数据知识我们介绍完了,回过头来重复一下access统计数据的内容:access统计数据类型数据发布的最小要求列表数据发布的最大要求单机数据库创建help资料,创建服务器环境publicmesh创建子账号、子账号密码及密钥/注册新建、删除子账号注册使用environment/web/mesh;/***创建environment/web/mesh;*/。/***注册新的mesh服务器*/。access[global]="new";。

我是学生,我没有说这样没有用啊!你为什么不问学校为什么不发workfromhome?简单直接,

我觉得我们学校有这么个数据发布平台就挺好。

这问题很难,我本人学校已经实现了。

现在上个网站就查一下往期的报表了,

我们只发布数据(没有数据的可以寄在本专业网站,我们只是给本专业同学提供报表查询,校外学生不接受)下载是没有的,课程展示可以用虚拟机下载。研究生我还是给点意见吧。不然你会想不到这样我们也实现了,虽然下载才几十个g。

怎样抓取网页数据(简单介绍一下如何通过python网络爬虫获取网站数据(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2021-09-13 12:14

以python为例,简单介绍一下如何通过python网络爬虫获取网站数据,主要分为静态网页数据的抓取和动态网页数据的抓取。实验环境为win10+python3.6+pycharm5.0,主要内容如下:百度爬虫:

静态网页数据。这里的数据嵌套在网页源码中,可以直接请求网页源码解析。让我简要介绍一下。以下是抓取尴尬百科全书数据的示例:

1. 首先打开原网页如下,这里假设要爬取的字段包括昵称、内容、搞笑数、评论数:

接下来查看网页的源码,如下图,可以看到所有的数据都嵌套在了网页中:

2. 那么对于上面的网页结构,我们可以直接编写爬虫代码,解析网页,提取我们需要的数据。测试代码如下,很简单,主要是使用requests+BeautifulSoup的组合,其中requests用于获取网页源码,BeautifulSoup用于解析网页提取数据:

点击运行这个程序,效果如下,我们需要的数据已经抓取成功:

动态网页数据 这里的数据不在网页的源代码中(所以直接请求页面是得不到任何数据的)。在大多数情况下,它存储在一个 json 文件中,并且仅在网页更新时。数据将被加载。我简单介绍一下这个方法。以下是在人人贷上抓取数据的示例:

1. 首先打开原网页,如下,这里假设要爬取的数据包括年利率、贷款标题、期限、金额和进度:

然后按F12调出开发者工具,点击“网络”->“XHR”,F5刷新页面,可以找到动态加载的json文件,如下,就是我们需要爬取的数据:

2. 然后根据这个json文件编写相应的代码,解析出我们需要的字段信息。测试代码如下,也很简单。主要采用requests+json的组合方式,其中requests用于请求json文件,json用于解析json文件提取数据:

点击运行这个程序,效果如下,我们已经成功抓取到了我们需要的数据:

至此,我们已经完成了使用python网络爬虫获取网站数据的过程。总的来说,整个过程非常简单。 Python内置了很多网络爬虫包和框架(scrapy等),可以快速获取网站数据,非常适合初学者学习和掌握。只要你有一定的爬虫基础,熟悉一下就行了。以上流程和代码可以很快掌握,当然也可以使用现成的爬虫软件,比如优采云、优采云等也可以,网上也有相关的教程和资料,很丰富,有兴趣的可以搜索一下,希望上面分享的内容对你有帮助,也欢迎大家评论留言补充。

如何提高百度爬虫的抓取频率

1、增加优质外链

很多人都知道,越优质的外链,网站的百度快照更新越快。为什么我们在这里谈论高质量的外部链接?如果垃圾链接很多,那用处不大,因为百度爬虫很少抓取垃圾链接,自然很少有机会通过垃圾链接进入你的网站。 查看全部

怎样抓取网页数据(简单介绍一下如何通过python网络爬虫获取网站数据(图))

以python为例,简单介绍一下如何通过python网络爬虫获取网站数据,主要分为静态网页数据的抓取和动态网页数据的抓取。实验环境为win10+python3.6+pycharm5.0,主要内容如下:百度爬虫:

静态网页数据。这里的数据嵌套在网页源码中,可以直接请求网页源码解析。让我简要介绍一下。以下是抓取尴尬百科全书数据的示例:

1. 首先打开原网页如下,这里假设要爬取的字段包括昵称、内容、搞笑数、评论数:

接下来查看网页的源码,如下图,可以看到所有的数据都嵌套在了网页中:

2. 那么对于上面的网页结构,我们可以直接编写爬虫代码,解析网页,提取我们需要的数据。测试代码如下,很简单,主要是使用requests+BeautifulSoup的组合,其中requests用于获取网页源码,BeautifulSoup用于解析网页提取数据:

点击运行这个程序,效果如下,我们需要的数据已经抓取成功:

动态网页数据 这里的数据不在网页的源代码中(所以直接请求页面是得不到任何数据的)。在大多数情况下,它存储在一个 json 文件中,并且仅在网页更新时。数据将被加载。我简单介绍一下这个方法。以下是在人人贷上抓取数据的示例:

1. 首先打开原网页,如下,这里假设要爬取的数据包括年利率、贷款标题、期限、金额和进度:

然后按F12调出开发者工具,点击“网络”->“XHR”,F5刷新页面,可以找到动态加载的json文件,如下,就是我们需要爬取的数据:

2. 然后根据这个json文件编写相应的代码,解析出我们需要的字段信息。测试代码如下,也很简单。主要采用requests+json的组合方式,其中requests用于请求json文件,json用于解析json文件提取数据:

点击运行这个程序,效果如下,我们已经成功抓取到了我们需要的数据:

至此,我们已经完成了使用python网络爬虫获取网站数据的过程。总的来说,整个过程非常简单。 Python内置了很多网络爬虫包和框架(scrapy等),可以快速获取网站数据,非常适合初学者学习和掌握。只要你有一定的爬虫基础,熟悉一下就行了。以上流程和代码可以很快掌握,当然也可以使用现成的爬虫软件,比如优采云、优采云等也可以,网上也有相关的教程和资料,很丰富,有兴趣的可以搜索一下,希望上面分享的内容对你有帮助,也欢迎大家评论留言补充。

如何提高百度爬虫的抓取频率

1、增加优质外链

很多人都知道,越优质的外链,网站的百度快照更新越快。为什么我们在这里谈论高质量的外部链接?如果垃圾链接很多,那用处不大,因为百度爬虫很少抓取垃圾链接,自然很少有机会通过垃圾链接进入你的网站。

怎样抓取网页数据(php.ini中的max_execution设置设置的大点软件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-09-13 09:07

爬取前记得将php.ini中的max_execution_time设置为较大的值,否则会报错。

一、用 Snoopy.class.php 抓取页面

一个非常可爱的班级名称。功能也很强大,用来模拟浏览器的功能,可以获取网页内容,发送表单等等。

1)我要抓取网站的一个列表页的内容,我要抓取的是全国医院信息的内容,如下图:

2)我自然是复制URL地址,使用Snoopy类抓取前10页的内容,并将内容放到本地,在本地创建一个html文件,稍后分析使用。

$snoopy=new Snoopy();

//医院list页面

for($i = 1; $i fetch($url);

file_put_contents("web/page/$i.html", $snoopy->results);

}

echo 'success';

3)奇怪的是,返回的不是国家内容,而是上海相关内容

4)后来怀疑里面可能设置了cookie,然后用firebug检查了一下,果然有惊天动地的内幕

5)在请求中放入cookie的值,并添加了设置语句$snoopy->cookies["_area_"],情况大不相同,顺利返回国家信息。

$snoopy=new Snoopy();

//医院list页面

$snoopy->cookies["_area_"] = '{"provinceId":"all","provinceName":"全国","cityId":"all","cityName":"不限"}';

for($i = 1; $i results;

}

2)使用phpQuery获取节点信息,DOM结构如下图所示:

使用一些phpQuery方法,结合DOM结构读取各个医院信息的URL地址。

for($i = 1; $i attr('href')); //医院详情

}

}

3)根据读取到的URL地址列表抓取指定页面。

$detailIndex = 1;

for($i = 1; $i results);

$detailIndex++;

}

}

FQ 工具下载:

克服障碍.rar

演示下载:

史努比类的一些说明:

类方法

获取($URI)

这是用来抓取网页内容的方法。

$URI 参数是被抓取网页的 URL 地址。

获取的结果存储在 $this->results 中。

如果你正在抓取一个帧,史努比会跟踪每一帧并将其存储在一个数组中,然后将其存储在 $this->results 中。

fetchtext($URI)

该方法与fetch()类似,唯一不同的是该方法会去除HTML标签等无关数据,只返回网页中的文本内容。

fetchform($URI)

该方法与fetch()类似,唯一不同的是该方法会去除HTML标签等无关数据,只返回网页中的表单内容(form)。

fetchlinks($URI)

这个方法和fetch()类似,唯一不同的是这个方法会去除HTML标签等无关数据,只返回网页中的链接。

默认情况下,相对链接会自动补全并转换成完整的网址。

提交($URI,$formvars)

此方法向$URL 指定的链接地址发送确认表单。 $formvars 是一个存储表单参数的数组。

提交文本($URI,$formvars)

该方法与submit()类似,唯一不同的是,该方法会去除HTML标签等无关数据,登录后只返回网页中的文本内容。

提交链接($URI)

这个方法类似于submit()。唯一不同的是,该方法会去除HTML标签等无关数据,只返回网页中的链接。

默认情况下,相对链接会自动补全并转换成完整的网址。

类属性

$host

连接的主机

$端口

连接端口

$proxy_host

使用的代理主机,如果有的话

$proxy_port

使用的代理主机端口,如果有的话

$代理

用户代理伪装(史努比 v0.1)

$referer

访问信息,如果有的话

$cookies

Cookies,如果有的话

$rawheaders

其他标题信息,如果有的话

$maxredirs

最大重定向次数,0=不允许(5)

$offsiteok

是否允许异地重定向。 (真实)

$expandlinks

是否补全链接地址(真)

$用户

经过身份验证的用户名(如果有)

$pass

经过身份验证的用户名(如果有)

$接受

http 接受类型 (image/gif, image/x-xbitmap, image/jpeg, image/pjpeg, */*)

$错误

在哪里报告错误,如果有的话

$response_code

服务器返回的响应码

$headers

服务器返回的头部信息

$maxlength

最长返回数据长度

$read_timeout

读取操作超时(需要 PHP 4 Beta 4+),设置为 0 表示没有超时

$timed_out

如果读取操作超时,该属性返回true(需要PHP 4 Beta 4+)

$maxframes

允许跟踪的最大帧数

$状态 查看全部

怎样抓取网页数据(php.ini中的max_execution设置设置的大点软件)

爬取前记得将php.ini中的max_execution_time设置为较大的值,否则会报错。

一、用 Snoopy.class.php 抓取页面

一个非常可爱的班级名称。功能也很强大,用来模拟浏览器的功能,可以获取网页内容,发送表单等等。

1)我要抓取网站的一个列表页的内容,我要抓取的是全国医院信息的内容,如下图:

2)我自然是复制URL地址,使用Snoopy类抓取前10页的内容,并将内容放到本地,在本地创建一个html文件,稍后分析使用。

$snoopy=new Snoopy();

//医院list页面

for($i = 1; $i fetch($url);

file_put_contents("web/page/$i.html", $snoopy->results);

}

echo 'success';

3)奇怪的是,返回的不是国家内容,而是上海相关内容

4)后来怀疑里面可能设置了cookie,然后用firebug检查了一下,果然有惊天动地的内幕

5)在请求中放入cookie的值,并添加了设置语句$snoopy->cookies["_area_"],情况大不相同,顺利返回国家信息。

$snoopy=new Snoopy();

//医院list页面

$snoopy->cookies["_area_"] = '{"provinceId":"all","provinceName":"全国","cityId":"all","cityName":"不限"}';

for($i = 1; $i results;

}

2)使用phpQuery获取节点信息,DOM结构如下图所示:

使用一些phpQuery方法,结合DOM结构读取各个医院信息的URL地址。

for($i = 1; $i attr('href')); //医院详情

}

}

3)根据读取到的URL地址列表抓取指定页面。

$detailIndex = 1;

for($i = 1; $i results);

$detailIndex++;

}

}

FQ 工具下载:

克服障碍.rar

演示下载:

史努比类的一些说明:

类方法

获取($URI)

这是用来抓取网页内容的方法。

$URI 参数是被抓取网页的 URL 地址。

获取的结果存储在 $this->results 中。

如果你正在抓取一个帧,史努比会跟踪每一帧并将其存储在一个数组中,然后将其存储在 $this->results 中。

fetchtext($URI)

该方法与fetch()类似,唯一不同的是该方法会去除HTML标签等无关数据,只返回网页中的文本内容。

fetchform($URI)

该方法与fetch()类似,唯一不同的是该方法会去除HTML标签等无关数据,只返回网页中的表单内容(form)。

fetchlinks($URI)

这个方法和fetch()类似,唯一不同的是这个方法会去除HTML标签等无关数据,只返回网页中的链接。

默认情况下,相对链接会自动补全并转换成完整的网址。

提交($URI,$formvars)

此方法向$URL 指定的链接地址发送确认表单。 $formvars 是一个存储表单参数的数组。

提交文本($URI,$formvars)

该方法与submit()类似,唯一不同的是,该方法会去除HTML标签等无关数据,登录后只返回网页中的文本内容。

提交链接($URI)

这个方法类似于submit()。唯一不同的是,该方法会去除HTML标签等无关数据,只返回网页中的链接。

默认情况下,相对链接会自动补全并转换成完整的网址。

类属性

$host

连接的主机

$端口

连接端口

$proxy_host

使用的代理主机,如果有的话

$proxy_port

使用的代理主机端口,如果有的话

$代理

用户代理伪装(史努比 v0.1)

$referer

访问信息,如果有的话

$cookies

Cookies,如果有的话

$rawheaders

其他标题信息,如果有的话

$maxredirs

最大重定向次数,0=不允许(5)

$offsiteok

是否允许异地重定向。 (真实)

$expandlinks

是否补全链接地址(真)

$用户

经过身份验证的用户名(如果有)

$pass

经过身份验证的用户名(如果有)

$接受

http 接受类型 (image/gif, image/x-xbitmap, image/jpeg, image/pjpeg, */*)

$错误

在哪里报告错误,如果有的话

$response_code

服务器返回的响应码

$headers

服务器返回的头部信息

$maxlength

最长返回数据长度

$read_timeout

读取操作超时(需要 PHP 4 Beta 4+),设置为 0 表示没有超时

$timed_out

如果读取操作超时,该属性返回true(需要PHP 4 Beta 4+)

$maxframes

允许跟踪的最大帧数

$状态

怎样抓取网页数据(百度抓取器会和网站首页的交互设计)

网站优化 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-10-15 21:16

首先,百度的爬虫会与网站的首页进行交互。拿到网站的主页后,会理解页面,理解收录(类型,值计算),其次,网站把主页上的所有超链接都提取出来。

如上图所示,首页上的超链接称为“post-links”。下一轮爬虫的时候,爬虫会继续和这些超链接的页面进行交互,得到页面进行细化,一层一层的继续下去。抓取一层,构成一个抓取循环。

一、爬取友好优化1、URL规范

任何资源都是通过 URL 获取的。URL是相对于网站的门牌号,所以URL规划很重要。尤其是在如上图所示的“待抓取网址”环境中,爬虫在首页的时候,并不知道网址长什么样子。

优秀网址的特点是主流、简单,你可能不想做出一些让人看起来直观的非主流风格。

优秀 URL 示例:

如上图,第一个是百度知道的链接。整个链接分为三个部分。第一部分是网站的站点,第二部分是资源类型,第三部分是资源ID。这种网址很简单,爬虫看起来很不错。

如上图,第三篇文章比百度多了一段。首先,第一段是网站的站点,第二段是站点的一级目录,第三段是站点的二级目录,最后一段是内容ID的网站。像这样的 URL 也符合标准。

不友好 URL 的示例:

如上图所示,这种链接乍一看很长很复杂。有经验的站长可以看到,这种URL收录字符,而这个URL收录文章的标题,导致URL很长。相对较长的 URL 并不优于简单的 URL。百度站长平台规则明确规定网址不能超过256字节。我个人建议 URL 长度控制在 100 字节和 100 个字符以内。足以显示资源的 URL。

如上图所示,该网址收录统计参数,可能导致重复爬取,浪费站点权限。因此,可能不使用参数。如果必须使用参数,也可以保留必要的参数。参数字符可以使用常规字符。连接器,例如“?” 和“&”,避免非主流连接器。

2、 合理发现链接

爬虫从首页一层一层的爬取,所以需要搞好首页和资源页的URL关系。这种爬虫爬行比较省力。

如上图所示,从首页到具体内容的超链接路径关系称为发现链接。目前大部分移动站不太重视发现链接关系,因此爬虫无法抓取到内容页面。

如上图所示,这两个站点是常见的移动网站构建方式。从链接发现的角度来看,这两类网站并不友好。

馈送流建议:

大多数进行流式传输的网站在后台都有大量数据。用户不断刷新时会出现新的内容,但无论刷新多少次,可能只能刷新到1%左右的内容,而爬虫等价于一个用户不可能爬取全部内容网站 这种方式,所以有些页面不会被抓取。即使您有 100 万个内容,您也可能只能对其进行抓取。1-2百万。

仅搜索条目:

如上图所示,首页只有一个搜索框。用户需要输入关键词才能找到对应的内容,但是爬虫不能输入关键词再爬,所以爬虫只能爬到首页后,没有反向链接,而且自然爬行和 收录 会不令人满意。

解决方案:

索引页下的内容按出版时间倒序排列。这样做的好处是搜索引擎甚至可以通过索引页抓取你的网站最新资源,并且新发布的资源应该在索引页中实时同步。,很多纯静态网页,内容更新了,但是首页(索引页)不出来。这会导致搜索引擎甚至无法通过索引页面抓取最新的资源。第三点是后链(latest文章的URL)需要在源码中直接暴露出来,方便搜索引擎抓取。最后,索引页不要越多越好。几个高质量的索引页就够了,比如长城,基本上只用首页来做。索引页。

最后,这里给大家一个更高效的解决方案,就是直接通过百度站长资源平台主动提交资源,让搜索引擎绕过索引页,直接抓取最新的资源。这里有两点需要注意。

Q:提交更多资源更好吗?

A:收录 效果的核心永远是内容的质量。如果大量低质量、泛滥的资源被提交,将导致惩罚性打击。

Q:为什么我提交了普通的收录却没有被抓到?

A:资源提交只能加速资源发现,不能保证短期抓取。当然,百度表示不断优化算法,让优质内容更快被抓取。

3、访问友好

抓取器必须与网站进行交互并保证网站的稳定性,这样抓取器才能正常抓取。那么访问友好性主要包括以下几个方面。

访问速度优化:

加载时间建议控制在2S以内,所以无论是用户还是爬虫,打开速度更快的网站会更受青睐,避免不必要的跳转。这种情况虽然是一小部分,但是在网站中还是有很多层次的跳转,所以对于爬虫来说,很有可能会在多层次跳转的同时断开。一般是把不带www的域名重定向到带WWW的域名,然后带WWW的域名需要重定向到https,最后更换新站。在这种情况下,将有三个或四个级别的重定向。如果有类似网站的修改,建议直接跳转到新域名。 查看全部

怎样抓取网页数据(百度抓取器会和网站首页的交互设计)

首先,百度的爬虫会与网站的首页进行交互。拿到网站的主页后,会理解页面,理解收录(类型,值计算),其次,网站把主页上的所有超链接都提取出来。

如上图所示,首页上的超链接称为“post-links”。下一轮爬虫的时候,爬虫会继续和这些超链接的页面进行交互,得到页面进行细化,一层一层的继续下去。抓取一层,构成一个抓取循环。

一、爬取友好优化1、URL规范

任何资源都是通过 URL 获取的。URL是相对于网站的门牌号,所以URL规划很重要。尤其是在如上图所示的“待抓取网址”环境中,爬虫在首页的时候,并不知道网址长什么样子。

优秀网址的特点是主流、简单,你可能不想做出一些让人看起来直观的非主流风格。

优秀 URL 示例:

如上图,第一个是百度知道的链接。整个链接分为三个部分。第一部分是网站的站点,第二部分是资源类型,第三部分是资源ID。这种网址很简单,爬虫看起来很不错。

如上图,第三篇文章比百度多了一段。首先,第一段是网站的站点,第二段是站点的一级目录,第三段是站点的二级目录,最后一段是内容ID的网站。像这样的 URL 也符合标准。

不友好 URL 的示例:

如上图所示,这种链接乍一看很长很复杂。有经验的站长可以看到,这种URL收录字符,而这个URL收录文章的标题,导致URL很长。相对较长的 URL 并不优于简单的 URL。百度站长平台规则明确规定网址不能超过256字节。我个人建议 URL 长度控制在 100 字节和 100 个字符以内。足以显示资源的 URL。

如上图所示,该网址收录统计参数,可能导致重复爬取,浪费站点权限。因此,可能不使用参数。如果必须使用参数,也可以保留必要的参数。参数字符可以使用常规字符。连接器,例如“?” 和“&”,避免非主流连接器。

2、 合理发现链接

爬虫从首页一层一层的爬取,所以需要搞好首页和资源页的URL关系。这种爬虫爬行比较省力。

如上图所示,从首页到具体内容的超链接路径关系称为发现链接。目前大部分移动站不太重视发现链接关系,因此爬虫无法抓取到内容页面。

如上图所示,这两个站点是常见的移动网站构建方式。从链接发现的角度来看,这两类网站并不友好。

馈送流建议:

大多数进行流式传输的网站在后台都有大量数据。用户不断刷新时会出现新的内容,但无论刷新多少次,可能只能刷新到1%左右的内容,而爬虫等价于一个用户不可能爬取全部内容网站 这种方式,所以有些页面不会被抓取。即使您有 100 万个内容,您也可能只能对其进行抓取。1-2百万。

仅搜索条目:

如上图所示,首页只有一个搜索框。用户需要输入关键词才能找到对应的内容,但是爬虫不能输入关键词再爬,所以爬虫只能爬到首页后,没有反向链接,而且自然爬行和 收录 会不令人满意。

解决方案:

索引页下的内容按出版时间倒序排列。这样做的好处是搜索引擎甚至可以通过索引页抓取你的网站最新资源,并且新发布的资源应该在索引页中实时同步。,很多纯静态网页,内容更新了,但是首页(索引页)不出来。这会导致搜索引擎甚至无法通过索引页面抓取最新的资源。第三点是后链(latest文章的URL)需要在源码中直接暴露出来,方便搜索引擎抓取。最后,索引页不要越多越好。几个高质量的索引页就够了,比如长城,基本上只用首页来做。索引页。

最后,这里给大家一个更高效的解决方案,就是直接通过百度站长资源平台主动提交资源,让搜索引擎绕过索引页,直接抓取最新的资源。这里有两点需要注意。

Q:提交更多资源更好吗?

A:收录 效果的核心永远是内容的质量。如果大量低质量、泛滥的资源被提交,将导致惩罚性打击。

Q:为什么我提交了普通的收录却没有被抓到?

A:资源提交只能加速资源发现,不能保证短期抓取。当然,百度表示不断优化算法,让优质内容更快被抓取。

3、访问友好

抓取器必须与网站进行交互并保证网站的稳定性,这样抓取器才能正常抓取。那么访问友好性主要包括以下几个方面。

访问速度优化:

加载时间建议控制在2S以内,所以无论是用户还是爬虫,打开速度更快的网站会更受青睐,避免不必要的跳转。这种情况虽然是一小部分,但是在网站中还是有很多层次的跳转,所以对于爬虫来说,很有可能会在多层次跳转的同时断开。一般是把不带www的域名重定向到带WWW的域名,然后带WWW的域名需要重定向到https,最后更换新站。在这种情况下,将有三个或四个级别的重定向。如果有类似网站的修改,建议直接跳转到新域名。

怎样抓取网页数据(解析XML网页链接来抓取指定的内容比如豆瓣电影排行榜,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-10-14 08:05

如果给你一个网页链接来抓取特定内容,比如豆瓣电影排名,怎么做?

其实网页内容的结构和XML很像,所以我们可以通过解析XML来解析HTML,但是两者的差距还是很大的,好吧,废话不多说,我们开始解析HTML。

然后有很多用于解析 XML 的库。这里我们选择libxml进行解析。因为libxml是C语言接口,所以找了个library-hpple,用objective-c来封装接口。它的地址是,然后网页使用豆瓣电影排名。地址是。

接下来,构建一个新项目。项目使用ARC,引入libxml2和hpple库,新建实体类movie。完整的项目结构如下:

movie的实现如下,这是一个实体类,根据爬取的网页内容确定

电影.h

@interface Movie : NSObject

@property(nonatomic, strong) NSString *name;

@property(nonatomic, strong) NSString *imageUrl;

@property(nonatomic, strong) NSString *descrition;

@property(nonatomic, strong) NSString *movieUrl;

@property(nonatomic) NSInteger ratingNumber;

@property(nonatomic, strong) NSString *comment;

@end

那么最重要的部分来了,不管网页的内容是什么,我们首先要获取网页的内容,下面是通过NSURLConnection获取整个网页的内容。

- (void)loadHTMLContent

{

NSString *movieUrl = MOVIE_URL;

NSString *urlString = [movieUrl stringByAddingPercentEscapesUsingEncoding:NSUTF8StringEncoding];

NSURL *url = [NSURL URLWithString:urlString];

NSURLRequest *request = [NSURLRequest requestWithURL:url];

[UIApplication sharedApplication].networkActivityIndicatorVisible = YES;

__weak ViewController *weak_self = self;

[NSURLConnection sendAsynchronousRequest:request queue:[NSOperationQueue mainQueue] completionHandler:^(NSURLResponse *response, NSData *data, NSError *error) {

if (nil == error) {

// NSString *retString = [[NSString alloc] initWithData:data encoding:NSUTF8StringEncoding];

// NSLog(@"%@", retString);

[weak_self parserHTML:data];

}

[UIApplication sharedApplication].networkActivityIndicatorVisible = NO;

}];

}

这里只是简单的访问web内容,一些HTTP和错误处理本文没有讨论,所以这里的代码比较简单,上面代码中有一个parserHTML:方法,就是解析获取到的web内容和解析网页内容之前,我们先拆解xpath。

假设一个简单的网页内容如下:

Some webpage

<p class=”normal”>This is the first paragraph

This is the second paragraph. This is in bold.

</p>

比如要获取title的内容,那么xpath表达式就是/html/head/title。如果要获取class="special"节点的内容,xpath为/html/body/p[@class='special']。

所以只要找到合适的xpath,就会得到对应的节点内容,接下来我们看看用hpple解析HTML

- (void)parserHTML:(NSData *)data

{

if (nil != data) {

TFHpple *movieParser = [TFHpple hppleWithHTMLData:data];

NSString *movieXpathQueryString = @"/html/body/div[@id='wrapper']/div[@id='content']/div[@class='grid-16-8 clearfix']/div[@class='article']/div[@class='indent']/table/tr/td/a[@class='nbg']";

NSArray *movieNodes = [movieParser searchWithXPathQuery:movieXpathQueryString];

for (TFHppleElement *element in movieNodes) {

Movie *m = [[Movie alloc] init];

m.name = [element objectForKey:@"title"];

m.movieUrl = [element objectForKey:@"href"];

for (TFHppleElement *child in element.children) {

if ([child.tagName isEqualToString:@"img"]) {

@try {

m.imageUrl = [child objectForKey:@"src"];

}

@catch (NSException *exception) {

}

}

}

[self.movies addObject:m];

}

[self.movieTableView reloadData];

}

}

在代码中找到首页对应节点的路径,然后searchWithXPathQuery得到一个数组,遍历组织数据显示在表格视图中。具体效果如下:

好了,网页的内容已经抓到了,实际的项目比这个复杂,所以,这只是一个指导性的例子。

参考:

注:本文为小涵原创,请支持原创!转载请附上原文链接: 查看全部

怎样抓取网页数据(解析XML网页链接来抓取指定的内容比如豆瓣电影排行榜,)

如果给你一个网页链接来抓取特定内容,比如豆瓣电影排名,怎么做?

其实网页内容的结构和XML很像,所以我们可以通过解析XML来解析HTML,但是两者的差距还是很大的,好吧,废话不多说,我们开始解析HTML。