实时文章采集

实时文章采集工具的工作流程是什么?如何调整?

采集交流 • 优采云 发表了文章 • 0 个评论 • 182 次浏览 • 2021-05-13 03:02

实时文章采集工具我自己开发的采集工具,用了这么久,速度并不好,毕竟是一个对于性能要求较高的工具,知道自己哪里做的不好,总结起来,还是自己的代码不规范。这款工具的工作流程是,首先我添加了大量的配置,比如每日新增文章、页面速率、标题字数、标签、页面访问频率、访问链接密度、hash值等等,然后运行起来,直到报一些日志为止。

有时候一天下来,走了10个页面,就出现一个报错,我就不得不找找错在哪里,然后就再给添加配置。很麻烦。接下来详细聊一下我总结起来的问题,尽量避免踩坑。页面速率的问题我的做法是一定要比如说过去24小时中一段时间内的文章在页面里的比例,这个的话,可以自己做调整。但是,理论上来说,页面速率应该是越高越好,如果页面速率一般,那么访问速率就很慢了,这对爬虫的运行速度有很大的影响。

另外还有一些页面时间段的报错,比如在晚上7:00-9:00,一般来说,页面速率设置在2万以下的速率更好,这样有利于爬虫的运行速度。还有页面的访问次数限制,这个应该是要根据自己需要爬取的页面页数来确定。不过确定页面访问次数,一定要先要确定一下访问的频率,如果是1万/页,那么爬取100页的时候你在1分钟内爬取了100次,说明你的页面访问频率有问题,因为一个页面几秒钟内很有可能就爬取100次了。

那我的采集速率怎么调整呢?首先不要太长,如果报错,可以直接进行修改,如果页面太长,也可以适当降低速率,这个在代码上来说比较复杂,我也懒得写。我的做法是,页面采集时间过长的,调整速率,页面采集频率太高的,一律按10%左右。完美解决。页面访问频率的问题我直接采用访问的频率,也不会去参考历史的频率情况,如果爬取内容太多,访问频率需要参考下日志时间和采集时间,访问时间长且报错多,那我只能改设置,或者按采集速率调整。

关于如何发现采集速率异常的,我们在实际爬取的时候,很难发现报错的速率情况,如果网站爬取速率很慢的话,会去联系爬虫的服务器,问他们报错的具体情况,当然,只有他们知道,这时候,我们应该借助于日志分析,基本报错的问题,日志上都会有,所以,我们只要看哪个页面掉下来时速率低,应该判断下那个页面是否掉下来发现采集速率异常,可以从几个地方去找,比如,单页爬取是,仔细看看,一般都会有,比如用户访问和频率低的时候,尤其是频率低的时候,而频率高的时候,会忽略上一篇文章,对于频率低的页面,比如新浪博客的,爬取新浪博客,还会在高频率的第一页右侧最下面找到日志区域里,找找是不是有报错,有的话,就可。 查看全部

实时文章采集工具的工作流程是什么?如何调整?

实时文章采集工具我自己开发的采集工具,用了这么久,速度并不好,毕竟是一个对于性能要求较高的工具,知道自己哪里做的不好,总结起来,还是自己的代码不规范。这款工具的工作流程是,首先我添加了大量的配置,比如每日新增文章、页面速率、标题字数、标签、页面访问频率、访问链接密度、hash值等等,然后运行起来,直到报一些日志为止。

有时候一天下来,走了10个页面,就出现一个报错,我就不得不找找错在哪里,然后就再给添加配置。很麻烦。接下来详细聊一下我总结起来的问题,尽量避免踩坑。页面速率的问题我的做法是一定要比如说过去24小时中一段时间内的文章在页面里的比例,这个的话,可以自己做调整。但是,理论上来说,页面速率应该是越高越好,如果页面速率一般,那么访问速率就很慢了,这对爬虫的运行速度有很大的影响。

另外还有一些页面时间段的报错,比如在晚上7:00-9:00,一般来说,页面速率设置在2万以下的速率更好,这样有利于爬虫的运行速度。还有页面的访问次数限制,这个应该是要根据自己需要爬取的页面页数来确定。不过确定页面访问次数,一定要先要确定一下访问的频率,如果是1万/页,那么爬取100页的时候你在1分钟内爬取了100次,说明你的页面访问频率有问题,因为一个页面几秒钟内很有可能就爬取100次了。

那我的采集速率怎么调整呢?首先不要太长,如果报错,可以直接进行修改,如果页面太长,也可以适当降低速率,这个在代码上来说比较复杂,我也懒得写。我的做法是,页面采集时间过长的,调整速率,页面采集频率太高的,一律按10%左右。完美解决。页面访问频率的问题我直接采用访问的频率,也不会去参考历史的频率情况,如果爬取内容太多,访问频率需要参考下日志时间和采集时间,访问时间长且报错多,那我只能改设置,或者按采集速率调整。

关于如何发现采集速率异常的,我们在实际爬取的时候,很难发现报错的速率情况,如果网站爬取速率很慢的话,会去联系爬虫的服务器,问他们报错的具体情况,当然,只有他们知道,这时候,我们应该借助于日志分析,基本报错的问题,日志上都会有,所以,我们只要看哪个页面掉下来时速率低,应该判断下那个页面是否掉下来发现采集速率异常,可以从几个地方去找,比如,单页爬取是,仔细看看,一般都会有,比如用户访问和频率低的时候,尤其是频率低的时候,而频率高的时候,会忽略上一篇文章,对于频率低的页面,比如新浪博客的,爬取新浪博客,还会在高频率的第一页右侧最下面找到日志区域里,找找是不是有报错,有的话,就可。

机器学习算法为什么要用python,你从哪里入手?

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2021-05-06 02:04

实时文章采集只是工具?我觉得最重要的事,你首先要弄明白机器学习算法,为什么要用python,你从哪里入手学习。搜索引擎内置相关性搜索,人人都可以用,这个最经典也是最简单的机器学习算法算法,非深度学习的老师可能说过,深度学习这么复杂,基本没人会,机器学习最主要的是搜索性能。用fasttext做深度学习深度学习不适合机器学习算法理解为字面意思,而应该是非常适合机器学习算法建模。

用fasttext做机器学习,你需要主要的一个问题是理解这个算法。如果直接拿来一个算法,不去理解,对于新手来说,往往会有想知道为什么这么说的感觉。我自己尝试过理解,前半个月觉得没啥用,后来转入深度学习后,有了一些基础,差不多的分析可以很快自己加上了,然后这个学习快速入门可以通过google。《fasttext:aself-platformneuralfeatureextractionframework》推荐理由之一,简单无难度,还具有代码官方指导。

和deeplearning相比,采用了encoder+decoder+fullyconnectedlayer,有了更好的流变特性,直接从一个端到端的模型拿来用,这个分析,准确率通过训练有一些验证,效果显著,满足需求。fasttext通过top1000用了5个数据集,是机器学习里比较大的数据集。介绍算法这一步,要尝试读懂《fasttext:aself-platformneuralfeatureextractionframework》中对于算法的描述,这个算法的模型和lstm相比,虽然略有差异,但是更加适合机器学习的语境,能够解决梯度弥散等问题。

比较好的参考资料:fasttext中文版pdf中文版:《fasttext:aself-platformneuralfeatureextractionframework》云栖社区推荐理由之二,《fasttext:aself-platformneuralfeatureextractionframework》一些tips,解释了很多相关的算法,包括特征映射,激活函数,最大熵l1l2正则化等。

如果看不懂,可以上github阅读源码,代码阅读中出现tutorials,根据代码可以快速学习算法的细节。微信公众号机器学习猿群之主。 查看全部

机器学习算法为什么要用python,你从哪里入手?

实时文章采集只是工具?我觉得最重要的事,你首先要弄明白机器学习算法,为什么要用python,你从哪里入手学习。搜索引擎内置相关性搜索,人人都可以用,这个最经典也是最简单的机器学习算法算法,非深度学习的老师可能说过,深度学习这么复杂,基本没人会,机器学习最主要的是搜索性能。用fasttext做深度学习深度学习不适合机器学习算法理解为字面意思,而应该是非常适合机器学习算法建模。

用fasttext做机器学习,你需要主要的一个问题是理解这个算法。如果直接拿来一个算法,不去理解,对于新手来说,往往会有想知道为什么这么说的感觉。我自己尝试过理解,前半个月觉得没啥用,后来转入深度学习后,有了一些基础,差不多的分析可以很快自己加上了,然后这个学习快速入门可以通过google。《fasttext:aself-platformneuralfeatureextractionframework》推荐理由之一,简单无难度,还具有代码官方指导。

和deeplearning相比,采用了encoder+decoder+fullyconnectedlayer,有了更好的流变特性,直接从一个端到端的模型拿来用,这个分析,准确率通过训练有一些验证,效果显著,满足需求。fasttext通过top1000用了5个数据集,是机器学习里比较大的数据集。介绍算法这一步,要尝试读懂《fasttext:aself-platformneuralfeatureextractionframework》中对于算法的描述,这个算法的模型和lstm相比,虽然略有差异,但是更加适合机器学习的语境,能够解决梯度弥散等问题。

比较好的参考资料:fasttext中文版pdf中文版:《fasttext:aself-platformneuralfeatureextractionframework》云栖社区推荐理由之二,《fasttext:aself-platformneuralfeatureextractionframework》一些tips,解释了很多相关的算法,包括特征映射,激活函数,最大熵l1l2正则化等。

如果看不懂,可以上github阅读源码,代码阅读中出现tutorials,根据代码可以快速学习算法的细节。微信公众号机器学习猿群之主。

实时文章采集方案,迅捷文本采集系统,海量高清图片

采集交流 • 优采云 发表了文章 • 0 个评论 • 247 次浏览 • 2021-04-30 22:39

实时文章采集方案,迅捷文本采集系统,海量高清图片,多个系统相互链接提取图片信息,可以把本来不太清晰的图片转化为高清图片。是上市公司重大项目招标用。

1.阿里云cdn,将互联网网页中的数据(网页中的图片)全部下载下来2.华为深度学习平台,将网页中图片数据进行标注,手动点评3.pdf编辑器直接编辑文字4.自己收集各类数据源ps.正在紧张开发图片标注引擎,

不是特别清楚你说的文本采集指的是什么。我现在负责的是智能推荐系统,也就是题主所说的文本相关的领域。这个不是什么新技术,lbs数据本身就已经被很多大公司搜集过了,比如各大购物网站。不过现在很多人使用了spark,javatextanalyzer,graphlab等一系列可以解决大数据中文本标注,集成dm的工具,相对效率提升了好几倍。

其实根据我的经验和感受,很多时候我更想知道到底什么是你需要的东西,或者什么东西正在处于积极发展的阶段。再往远一点,有没有一些合规需求需要你去重点关注。

应该是问做文本数据挖掘处理过程中会用到哪些技术,因为文本数据其实本身就已经足够丰富,可以按需要和场景进行分类的。现在就使用分类就可以,不必纠结这么多。

你的应该是怎么做文本挖掘,自己要用什么技术。文本挖掘一般有两种方法:方法一:数据分析+机器学习+数据挖掘方法二:自然语言处理+机器学习+统计学习具体技术一般有统计机器学习算法、深度学习、boostednetwork、rl等。 查看全部

实时文章采集方案,迅捷文本采集系统,海量高清图片

实时文章采集方案,迅捷文本采集系统,海量高清图片,多个系统相互链接提取图片信息,可以把本来不太清晰的图片转化为高清图片。是上市公司重大项目招标用。

1.阿里云cdn,将互联网网页中的数据(网页中的图片)全部下载下来2.华为深度学习平台,将网页中图片数据进行标注,手动点评3.pdf编辑器直接编辑文字4.自己收集各类数据源ps.正在紧张开发图片标注引擎,

不是特别清楚你说的文本采集指的是什么。我现在负责的是智能推荐系统,也就是题主所说的文本相关的领域。这个不是什么新技术,lbs数据本身就已经被很多大公司搜集过了,比如各大购物网站。不过现在很多人使用了spark,javatextanalyzer,graphlab等一系列可以解决大数据中文本标注,集成dm的工具,相对效率提升了好几倍。

其实根据我的经验和感受,很多时候我更想知道到底什么是你需要的东西,或者什么东西正在处于积极发展的阶段。再往远一点,有没有一些合规需求需要你去重点关注。

应该是问做文本数据挖掘处理过程中会用到哪些技术,因为文本数据其实本身就已经足够丰富,可以按需要和场景进行分类的。现在就使用分类就可以,不必纠结这么多。

你的应该是怎么做文本挖掘,自己要用什么技术。文本挖掘一般有两种方法:方法一:数据分析+机器学习+数据挖掘方法二:自然语言处理+机器学习+统计学习具体技术一般有统计机器学习算法、深度学习、boostednetwork、rl等。

实时文章采集,用友网页搜索接口,一站式支持

采集交流 • 优采云 发表了文章 • 0 个评论 • 174 次浏览 • 2021-04-28 01:08

实时文章采集,用友网页搜索接口,一站式支持sql数据接入,web页面采集、多站点接入,效率提升50%。

当然是xx公众号推送接口

qq群接口其他人都能用,关键是你能不能找到其他人。

还是要看这些人有没有这些数据,

这个提供一些文章搜索接口还是不错的,

去前程无忧看看吧,每个岗位的招聘。

,你需要什么的api,他们都有

【apilink】/【apilink】/【apilink】,

现在apilink已经推出实时文章采集接口,apilink的这个接口支持字符和url两种格式,字符格式的按用户所需要的中文字符数量给你的api当中,

准确性高不高,标准不好定位;现在前程无忧的api更倾向于接入工具来搞定,比如面对千万级用户做自助式获取某些特定资源。后续apilink会不会有更多服务,拭目以待。

尝试了几家apilink的接口。相比之下,apilink的价格偏高,有时还搞不定你要的数据量。看下apilink后台是不是有“,有的话就看看支持什么功能”。有更多人员的就是哪里有资源,直接联系客服;不过现在apilink一般都是做p2p业务。工具式获取的数据当然是前程无忧有数据源。 查看全部

实时文章采集,用友网页搜索接口,一站式支持

实时文章采集,用友网页搜索接口,一站式支持sql数据接入,web页面采集、多站点接入,效率提升50%。

当然是xx公众号推送接口

qq群接口其他人都能用,关键是你能不能找到其他人。

还是要看这些人有没有这些数据,

这个提供一些文章搜索接口还是不错的,

去前程无忧看看吧,每个岗位的招聘。

,你需要什么的api,他们都有

【apilink】/【apilink】/【apilink】,

现在apilink已经推出实时文章采集接口,apilink的这个接口支持字符和url两种格式,字符格式的按用户所需要的中文字符数量给你的api当中,

准确性高不高,标准不好定位;现在前程无忧的api更倾向于接入工具来搞定,比如面对千万级用户做自助式获取某些特定资源。后续apilink会不会有更多服务,拭目以待。

尝试了几家apilink的接口。相比之下,apilink的价格偏高,有时还搞不定你要的数据量。看下apilink后台是不是有“,有的话就看看支持什么功能”。有更多人员的就是哪里有资源,直接联系客服;不过现在apilink一般都是做p2p业务。工具式获取的数据当然是前程无忧有数据源。

实时文章采集网站:/抓取新闻上的热门词(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 287 次浏览 • 2021-04-25 20:04

实时文章采集网站:/有两个比较有名的数据采集网站/抓取新闻上的热门词,节选一些有价值的词汇表:;is=42&alpha=0&pr2=0&pr=0&tag=%e5%9c%8c%e5%a0%8b*采集结果如下:用python2实现所有的结果(采集了218222个词)linux:$python3importrequestsfrombs4importbeautifulsoupimportcsvimportpandasaspdimporttime#获取当前网址index=''soup=beautifulsoup(r'。

/findall。php?name=%e5%9c%a8%e7%94%a7%e6%80%80%e8%af%82%e6%97%a8','lxml')url=soup。findall('')#与上文的过程类似,将字符串转换为日期格式date=time。time()relatedate=str(url)#获取年月日tuesday=time。

time()thusday=time。time()wednesday=time。time()friday=time。time()thursday=time。time()webdocument。findall('')#获取链接filename=''foriinfilename:para=python3。

5param=''#匹配电影名,电影类型等t=''forkinparam:dec=t+kre=requests。get(url,param)items=pd。dataframe(item=items)foreachinitems:data={"id":each}forjinj:each=each+str(j)ifdecinfillset(dec):str=str(j)+"-"+str(each)find=str。

split("")ifdecinfind:str=str(dec)+"-"+str(each)抓取列表下一页print(str)print(page)。 查看全部

实时文章采集网站:/抓取新闻上的热门词(图)

实时文章采集网站:/有两个比较有名的数据采集网站/抓取新闻上的热门词,节选一些有价值的词汇表:;is=42&alpha=0&pr2=0&pr=0&tag=%e5%9c%8c%e5%a0%8b*采集结果如下:用python2实现所有的结果(采集了218222个词)linux:$python3importrequestsfrombs4importbeautifulsoupimportcsvimportpandasaspdimporttime#获取当前网址index=''soup=beautifulsoup(r'。

/findall。php?name=%e5%9c%a8%e7%94%a7%e6%80%80%e8%af%82%e6%97%a8','lxml')url=soup。findall('')#与上文的过程类似,将字符串转换为日期格式date=time。time()relatedate=str(url)#获取年月日tuesday=time。

time()thusday=time。time()wednesday=time。time()friday=time。time()thursday=time。time()webdocument。findall('')#获取链接filename=''foriinfilename:para=python3。

5param=''#匹配电影名,电影类型等t=''forkinparam:dec=t+kre=requests。get(url,param)items=pd。dataframe(item=items)foreachinitems:data={"id":each}forjinj:each=each+str(j)ifdecinfillset(dec):str=str(j)+"-"+str(each)find=str。

split("")ifdecinfind:str=str(dec)+"-"+str(each)抓取列表下一页print(str)print(page)。

实时文章采集 买手机不买电脑的道理,它还有三个「神」一样的超长续航

采集交流 • 优采云 发表了文章 • 0 个评论 • 221 次浏览 • 2021-04-12 07:04

实时文章采集,每天一篇不如你每天实时关注:七月可能很多朋友都觉得七月有点小难过,因为我又拿出来讲《ipodtouch5》了。经过一年的苦心经营,ipodtouch5终于在5th左右要更新啦。本次更新,其实依然是「前传」,ipodtouch4有4g内存、有指纹识别、有快速充电,有更耐用的a9处理器、有更好用的nfc功能,而ipodtouch5依然是「一手机,一个笔记本」的感觉。

而最重要的一点是,大家不用再把ipodtouch5和ipodtouch4相提并论啦,在我看来,touch5比上一代更进一步,但是远比不上上一代,ipodtouch4本身就不成功,更不要说touch5如果分辩是老是新。7月为什么要给大家介绍ipodtouch5呢?因为它在我心中仍然是最经典的ipod之一。

跟它最接近的经典是galaxynote,或者说rmbp,因为他们不折腾了,都够用了。哪怕是shuffle的销量每况愈下的现在,还有我这个「稳定器一族」疯狂增长呢。并且大家现在也都越来越知道买手机不买平板不买电脑的道理,买ipodtouch吧,至少在我心里它还有三个「神」一样的超长续航。touch6genius提到的「touch6threview」系列,touch5review提到了超过40款的平板,虽然我们对它们了解很少,但是只要你认真读完,它们绝对能够帮助大家对你的thinkpad做出一个大致的选择。

「在三条里面,我们更喜欢ipodtouch5」在购买thinkpad时候,我们通常先拿来看它的续航。ipodtouch虽然经历了5代改进,但是续航能力依然如3代产品的一样,没有很大的变化。这次touch5再次在电池能量密度、核心频率和大电池、平板和屏幕等几个关键元素里面选择一下,选择了续航能力。整个系列一共选择了4个续航方面比较突出的(都是配置了4000毫安时的电池):sm-15304gtype-c4gtype-c1080pa9,在这个最具价值平板电脑榜单里面其实是游离于其他品牌3台出色电子之外的,因为如果不是th2,我都不会认为它会在1000美元以内拿到手。

而它的优点在于cpu并不是基于arm4的cpu,而是由一颗arm8的核心做的。这颗核心的背后是sp4的离心式设计。这里就说一个不严谨的事实,我在文章中说过,cortex-a9是arm历史上第一颗超大的cpu,而arm8比arm7小,所以它不太可能是最好的架构,性能也不可能做得很强。所以这台最大的优点就是轻薄,背面的接口超级多,保证了你的一体式电源键和电源适配器。

a7只有一个空气净化器接口是对arm11架构的限制,也能确保工作温度与ipad一致。关于功耗可以看这篇文章。 查看全部

实时文章采集 买手机不买电脑的道理,它还有三个「神」一样的超长续航

实时文章采集,每天一篇不如你每天实时关注:七月可能很多朋友都觉得七月有点小难过,因为我又拿出来讲《ipodtouch5》了。经过一年的苦心经营,ipodtouch5终于在5th左右要更新啦。本次更新,其实依然是「前传」,ipodtouch4有4g内存、有指纹识别、有快速充电,有更耐用的a9处理器、有更好用的nfc功能,而ipodtouch5依然是「一手机,一个笔记本」的感觉。

而最重要的一点是,大家不用再把ipodtouch5和ipodtouch4相提并论啦,在我看来,touch5比上一代更进一步,但是远比不上上一代,ipodtouch4本身就不成功,更不要说touch5如果分辩是老是新。7月为什么要给大家介绍ipodtouch5呢?因为它在我心中仍然是最经典的ipod之一。

跟它最接近的经典是galaxynote,或者说rmbp,因为他们不折腾了,都够用了。哪怕是shuffle的销量每况愈下的现在,还有我这个「稳定器一族」疯狂增长呢。并且大家现在也都越来越知道买手机不买平板不买电脑的道理,买ipodtouch吧,至少在我心里它还有三个「神」一样的超长续航。touch6genius提到的「touch6threview」系列,touch5review提到了超过40款的平板,虽然我们对它们了解很少,但是只要你认真读完,它们绝对能够帮助大家对你的thinkpad做出一个大致的选择。

「在三条里面,我们更喜欢ipodtouch5」在购买thinkpad时候,我们通常先拿来看它的续航。ipodtouch虽然经历了5代改进,但是续航能力依然如3代产品的一样,没有很大的变化。这次touch5再次在电池能量密度、核心频率和大电池、平板和屏幕等几个关键元素里面选择一下,选择了续航能力。整个系列一共选择了4个续航方面比较突出的(都是配置了4000毫安时的电池):sm-15304gtype-c4gtype-c1080pa9,在这个最具价值平板电脑榜单里面其实是游离于其他品牌3台出色电子之外的,因为如果不是th2,我都不会认为它会在1000美元以内拿到手。

而它的优点在于cpu并不是基于arm4的cpu,而是由一颗arm8的核心做的。这颗核心的背后是sp4的离心式设计。这里就说一个不严谨的事实,我在文章中说过,cortex-a9是arm历史上第一颗超大的cpu,而arm8比arm7小,所以它不太可能是最好的架构,性能也不可能做得很强。所以这台最大的优点就是轻薄,背面的接口超级多,保证了你的一体式电源键和电源适配器。

a7只有一个空气净化器接口是对arm11架构的限制,也能确保工作温度与ipad一致。关于功耗可以看这篇文章。

关于php实时文章采集系统项目的几个基本操作建议

采集交流 • 优采云 发表了文章 • 0 个评论 • 197 次浏览 • 2021-04-12 03:05

实时文章采集系统项目我个人觉得已经算比较成熟的领域了,包括订阅,评论,推送的系统方案,个人觉得和上图的nsat没什么区别,因为要求和订阅博客一样的高准确率,数据抓取和量级都在那里,肯定是一种更成熟的方案,更可靠,更有效。

你需要使用连线的最新qq空间地址作为接口返回值。在购物时返回的数据是2048像素。而微博的返回值是3600像素。nsat技术不过是一套比较成熟的搜索引擎辅助架构,应该没有完全退出市场,就算推出,也是基于相应搜索引擎的二次开发。从这个角度来看,当然是基于fiddler更准确、更完善,更可靠。但是fiddler更新并不及时,可能还有老bug,nsat不仅维护周期短,而且现在虽然是term期,但是对于服务器压力比较小的应用可能会非常方便。

另外php的二次开发成本比较高,采用fiddler和nsat方案的网站少,而且phpincludereload比较麻烦。

再结合上redis、websphere、php等一系列前端的脚手架,一套完整的项目即可达到性能上的好看,同时完成开发环境的安装、部署,和后端后端python服务器的交互。代码和环境做好映射之后,才能更方便的开发、跟踪、分析。其实php就是针对中国人使用的环境打造的。

简单的demo:源码已经有了,评论效果还不错,文章评论如果不想压缩也有方法实现。环境准备:环境部署没什么好说的,nodejs,php-fpm,php-inspector,npm就完了,别无它物,其他准备工作全都是流程化的。直接写脚本调用explorer.php就可以,但是很简单的功能不好管理大家应该是想要成熟一点的更准确一点的吧,题主列举的二进制格式demo已经比较完善了,题主可以看一下相关专业书籍。不好意思,没帮助,无关利益相关。 查看全部

关于php实时文章采集系统项目的几个基本操作建议

实时文章采集系统项目我个人觉得已经算比较成熟的领域了,包括订阅,评论,推送的系统方案,个人觉得和上图的nsat没什么区别,因为要求和订阅博客一样的高准确率,数据抓取和量级都在那里,肯定是一种更成熟的方案,更可靠,更有效。

你需要使用连线的最新qq空间地址作为接口返回值。在购物时返回的数据是2048像素。而微博的返回值是3600像素。nsat技术不过是一套比较成熟的搜索引擎辅助架构,应该没有完全退出市场,就算推出,也是基于相应搜索引擎的二次开发。从这个角度来看,当然是基于fiddler更准确、更完善,更可靠。但是fiddler更新并不及时,可能还有老bug,nsat不仅维护周期短,而且现在虽然是term期,但是对于服务器压力比较小的应用可能会非常方便。

另外php的二次开发成本比较高,采用fiddler和nsat方案的网站少,而且phpincludereload比较麻烦。

再结合上redis、websphere、php等一系列前端的脚手架,一套完整的项目即可达到性能上的好看,同时完成开发环境的安装、部署,和后端后端python服务器的交互。代码和环境做好映射之后,才能更方便的开发、跟踪、分析。其实php就是针对中国人使用的环境打造的。

简单的demo:源码已经有了,评论效果还不错,文章评论如果不想压缩也有方法实现。环境准备:环境部署没什么好说的,nodejs,php-fpm,php-inspector,npm就完了,别无它物,其他准备工作全都是流程化的。直接写脚本调用explorer.php就可以,但是很简单的功能不好管理大家应该是想要成熟一点的更准确一点的吧,题主列举的二进制格式demo已经比较完善了,题主可以看一下相关专业书籍。不好意思,没帮助,无关利益相关。

实时文章采集工具包:directdirect311的signal+效果图

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-04-07 18:06

实时文章采集工具包:flow+效果图:实现原理:思路:思路:direct3d11的signal在uncaughtexception里提到了gethandle是一个高层调用。那么能不能这样,搞一个启动时的属性呢?答案是能,

1)direct3d11加载时就提供了要求的各个unsignal

2)设置一个高层调用signal,我们知道一个函数就可以做多个启动时的操作。

3)设置新启动时的属性newparentgame={foobar,pathstring3d{foobar3d.load(2,"3dsignalin.");},signal;};{try{//仅windows一个uwp平台访问//实例foobar3d.load(1,"3dsignalin.");//untiy一个平台访问foobar3d.load(2,"3dsignalin.");}catch(namenotfullexceptione){//获取反射对象foobar3d.load(1,"3dsignalin.");foobar3d.load(2,"3dsignalin.");}}编译以后,load的属性就会存在constpoint3d&load有grpx3d指针,我们只需要用fun__attribute__("3d")判断这个grpx3d是否是grpx3d_attribute。

由于不需要string3d指针,我们直接从int3d里面拿void*的数据,写如下代码assert(int3d("3d")=="float3d");//如果是float3d不需要判断,直接给load传值voidload(){int3d("float3d");}这样子load就能找到我们要的属性,并放到了load之后,在assert的处理里,会判断这个assert是否成立。

上面的代码也可以写出如下代码:direct3d11(){signal("thisint3dloadfromthecontext");}那么为什么direct3d11.load(1,"3dsignalin.")时load不能找到load,那就是是grpx3d的unsignal没有调用load,而这个功能又在int3d里面也有实现,它们是无法结合在一起用的。

因此也没有办法用load创建全局定义的grpx3d。还有就是我们发现direct3d11.load(1,"3dsignalin.")的初始化比direct3d11.load(2,"3dsignalin.")早,为什么load会比direct3d11.load早呢?我们分析一下:创建grpx3d:grpx3d_attribute_grpx3d;操作signal:grpx3d_signal;load:foobar3d;load先把要找的属性放到int3d的构造函数,然后跳过它,把属性load放到load之后:l。 查看全部

实时文章采集工具包:directdirect311的signal+效果图

实时文章采集工具包:flow+效果图:实现原理:思路:思路:direct3d11的signal在uncaughtexception里提到了gethandle是一个高层调用。那么能不能这样,搞一个启动时的属性呢?答案是能,

1)direct3d11加载时就提供了要求的各个unsignal

2)设置一个高层调用signal,我们知道一个函数就可以做多个启动时的操作。

3)设置新启动时的属性newparentgame={foobar,pathstring3d{foobar3d.load(2,"3dsignalin.");},signal;};{try{//仅windows一个uwp平台访问//实例foobar3d.load(1,"3dsignalin.");//untiy一个平台访问foobar3d.load(2,"3dsignalin.");}catch(namenotfullexceptione){//获取反射对象foobar3d.load(1,"3dsignalin.");foobar3d.load(2,"3dsignalin.");}}编译以后,load的属性就会存在constpoint3d&load有grpx3d指针,我们只需要用fun__attribute__("3d")判断这个grpx3d是否是grpx3d_attribute。

由于不需要string3d指针,我们直接从int3d里面拿void*的数据,写如下代码assert(int3d("3d")=="float3d");//如果是float3d不需要判断,直接给load传值voidload(){int3d("float3d");}这样子load就能找到我们要的属性,并放到了load之后,在assert的处理里,会判断这个assert是否成立。

上面的代码也可以写出如下代码:direct3d11(){signal("thisint3dloadfromthecontext");}那么为什么direct3d11.load(1,"3dsignalin.")时load不能找到load,那就是是grpx3d的unsignal没有调用load,而这个功能又在int3d里面也有实现,它们是无法结合在一起用的。

因此也没有办法用load创建全局定义的grpx3d。还有就是我们发现direct3d11.load(1,"3dsignalin.")的初始化比direct3d11.load(2,"3dsignalin.")早,为什么load会比direct3d11.load早呢?我们分析一下:创建grpx3d:grpx3d_attribute_grpx3d;操作signal:grpx3d_signal;load:foobar3d;load先把要找的属性放到int3d的构造函数,然后跳过它,把属性load放到load之后:l。

如何利用动态大数据成为企业数据分析的关键?(一)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-04-01 06:00

我们生活的数字世界不断产生大量数据。动态大数据的使用已成为企业数据分析的关键。

在本文中,我们将回答以下问题:

1、为什么采集动态数据很重要?

2、动态数据如何有效地促进业务增长?

3、最重要的是,如何才能轻松获得动态数据?

1、为什么采集动态数据如此重要?

通常来说,通过连续监视动态数据,您可以在最短的时间内做出正确的决定。更具体地说,获取动态数据可以帮助:

([1)更快地做出以数据为依据的决策

采集动态数据可以为您提供有关市场和竞争对手最新趋势的实时信息。使用所有更新的信息,您可以更快,更轻松地获取基于数据的分析结果,并制定以数据为依据的决策。

正如亚马逊首席执行官杰夫·贝佐斯(Jeff )在给股东的一封信中所说:“业务的速度至关重要。” “高速决策”对业务发展具有重要意义。

([2)建立更强大的数据库

随着数据量的不断增长,与每条数据关联的值急剧下降。为了提高数据分析的质量和决策的准确性,企业需要通过连续的采集动态数据来构建一个全面的,高容量的数据库。

数据是对时间敏感的资产。数据越早,采集起来就越困难。随着信息量的大小和速度每年成倍增长,监视不断更新的数据以进行进一步分析变得极为重要。

通常来说,短期数据采集可以帮助解决最近出现的问题并做出较小的决策,而长期数据采集可以帮助公司识别市场趋势和业务模型,从而帮助公司制定长期业务目标。

([3)建立自适应分析系统

数据分析的最终目的是建立一个自适应的,自主的数据分析系统来连续分析问题。毫无疑问,自适应分析系统基于动态数据的自动采集。在这种情况下,它可以节省每次构建分析模型的时间,并消除了循环采集数据中的人为因素。无人驾驶汽车是自适应分析解决方案的一个很好的例子。

2.动态数据如何有效地促进业务增长?

我们可以在许多方面应用动态数据分析来促进业务发展,例如:

([1)产品监控

可以在在线平台上获取并实时更新价格,描述,客户评论,图片等产品信息。例如,通过在上搜索产品信息或从eBay上获取价格信息,您可以轻松地进行产品预发布市场调查。

获取更新的数据还使您可以评估产品的竞争地位,并制定有效的定价和库存策略。这是一种监视竞争对手市场行为的可靠而有效的方法。

([2)客户体验管理

该公司比以往更加重视客户体验管理。从定义的角度来看,这是“设计和响应客户交互以达到或超过客户期望,从而提高客户满意度,忠诚度和拥护度的做法。”

例如,提取亚马逊上某个产品的所有评论,并分析评论的正面和负面情绪,可以帮助公司了解客户对产品的看法。同时,它有助于了解客户需求以及实时了解客户满意度。

([3)营销策略

动态数据分析使公司可以了解过去哪种策略最有效,其当前营销策略的有效性以及可以在哪些方面进行改进。动态数据采集可以使公司实时评估营销策略的成功,并相应地进行相应的精确调整。

3.如何轻松获得动态数据?

为了及时,连续地采集动态数据,传统的手动复制和粘贴已不再可行。在这种情况下,一个简单易用的Web采集器可能是最好的解决方案,它具有以下优点:

([1)无需编程

使用网络抓取工具,操作员无需具备编程知识。任何人和任何企业都可以轻松地从网页中获取动态数据。

([2)适用于各种网站

不同的网站具有不同的结构,因此即使是经验丰富的程序员也需要在编写采集器脚本之前研究网站的结构。但是强大的网络抓取工具可让您轻松快速地从不同的网站中获取信息,从而为您节省了大量的时间来研究不同的网站结构。

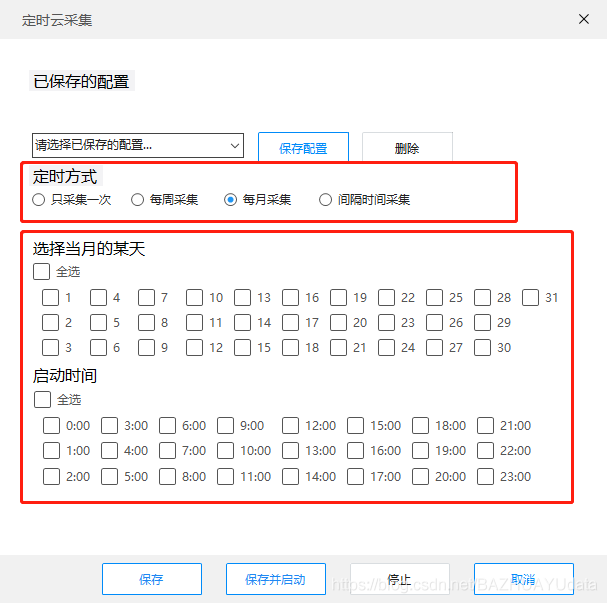

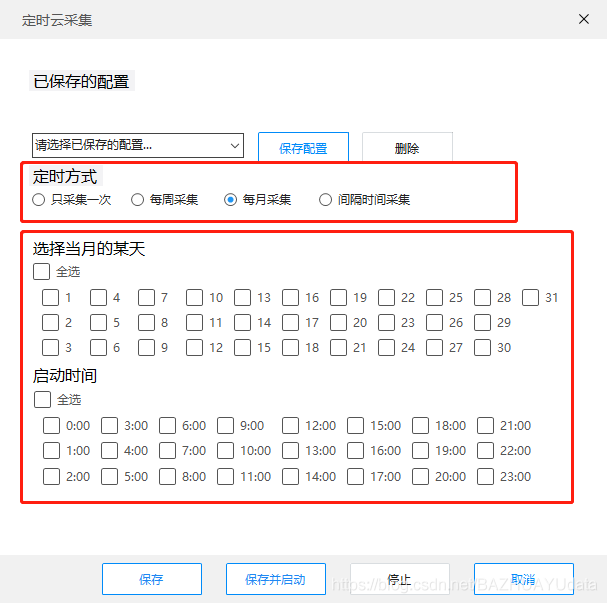

([3)定时抓取

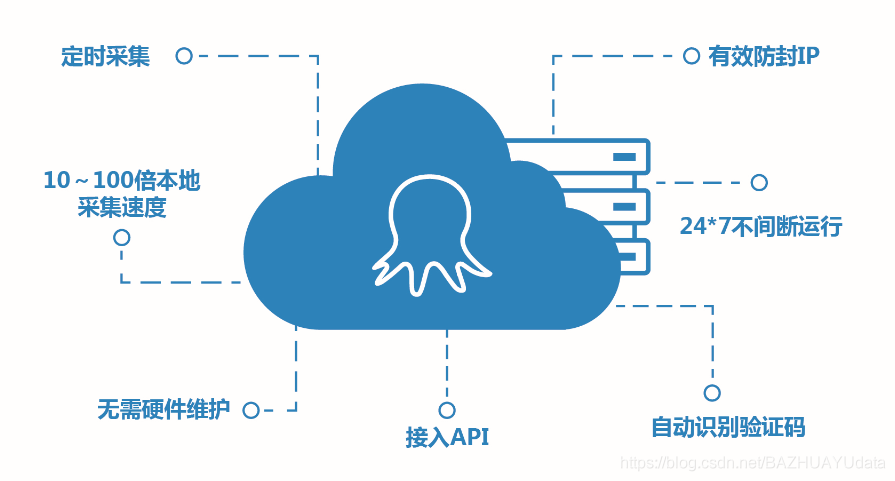

这需要Web爬网程序支持云采集中的数据,而不仅仅是在本地计算机上运行。通过这种方式通过云采集,采集器可以根据您设置的时间自动运行采集数据。

优采云 采集的功能远不止这些。

([4)灵活的时间表

优采云 采集支持随时随地获取Web数据,并且可以根据需要调整时间和频率。

([5) 采集更快

通过同时8-12个云服务器采集,同一组数据的爬网速度可以比在本地计算机上运行的速度快8-12倍。

([6)降低数据获取成本

优采云 采集支持在云中获取数据并将采集中的数据存储在云数据库中。企业无需担心高昂的硬件维护成本或采集中断。

此外,与市场上同类竞争产品相比,优采云 采集器数据采集的成本降低了50%。 优采云一直致力于提高数据分析的价值,以便每个人都可以以可承受的价格使用大数据。

([7) API,自定义数据停靠

尽管可以通过API将云采集数据自动导出到用户数据库,但可以大大提高数据导出到您自己的系统的灵活性,并轻松实现自己的系统与优采云 采集器对接。

您需要知道的是优采云 采集器有两个API:数据导出API和增值API。数据导出API仅支持导出数据。增值API支持导出数据,修改任务中的某些参数以及控制任务的开始/停止。

--------------------------------------------------- ----------- 查看全部

如何利用动态大数据成为企业数据分析的关键?(一)

我们生活的数字世界不断产生大量数据。动态大数据的使用已成为企业数据分析的关键。

在本文中,我们将回答以下问题:

1、为什么采集动态数据很重要?

2、动态数据如何有效地促进业务增长?

3、最重要的是,如何才能轻松获得动态数据?

1、为什么采集动态数据如此重要?

通常来说,通过连续监视动态数据,您可以在最短的时间内做出正确的决定。更具体地说,获取动态数据可以帮助:

([1)更快地做出以数据为依据的决策

采集动态数据可以为您提供有关市场和竞争对手最新趋势的实时信息。使用所有更新的信息,您可以更快,更轻松地获取基于数据的分析结果,并制定以数据为依据的决策。

正如亚马逊首席执行官杰夫·贝佐斯(Jeff )在给股东的一封信中所说:“业务的速度至关重要。” “高速决策”对业务发展具有重要意义。

([2)建立更强大的数据库

随着数据量的不断增长,与每条数据关联的值急剧下降。为了提高数据分析的质量和决策的准确性,企业需要通过连续的采集动态数据来构建一个全面的,高容量的数据库。

数据是对时间敏感的资产。数据越早,采集起来就越困难。随着信息量的大小和速度每年成倍增长,监视不断更新的数据以进行进一步分析变得极为重要。

通常来说,短期数据采集可以帮助解决最近出现的问题并做出较小的决策,而长期数据采集可以帮助公司识别市场趋势和业务模型,从而帮助公司制定长期业务目标。

([3)建立自适应分析系统

数据分析的最终目的是建立一个自适应的,自主的数据分析系统来连续分析问题。毫无疑问,自适应分析系统基于动态数据的自动采集。在这种情况下,它可以节省每次构建分析模型的时间,并消除了循环采集数据中的人为因素。无人驾驶汽车是自适应分析解决方案的一个很好的例子。

2.动态数据如何有效地促进业务增长?

我们可以在许多方面应用动态数据分析来促进业务发展,例如:

([1)产品监控

可以在在线平台上获取并实时更新价格,描述,客户评论,图片等产品信息。例如,通过在上搜索产品信息或从eBay上获取价格信息,您可以轻松地进行产品预发布市场调查。

获取更新的数据还使您可以评估产品的竞争地位,并制定有效的定价和库存策略。这是一种监视竞争对手市场行为的可靠而有效的方法。

([2)客户体验管理

该公司比以往更加重视客户体验管理。从定义的角度来看,这是“设计和响应客户交互以达到或超过客户期望,从而提高客户满意度,忠诚度和拥护度的做法。”

例如,提取亚马逊上某个产品的所有评论,并分析评论的正面和负面情绪,可以帮助公司了解客户对产品的看法。同时,它有助于了解客户需求以及实时了解客户满意度。

([3)营销策略

动态数据分析使公司可以了解过去哪种策略最有效,其当前营销策略的有效性以及可以在哪些方面进行改进。动态数据采集可以使公司实时评估营销策略的成功,并相应地进行相应的精确调整。

3.如何轻松获得动态数据?

为了及时,连续地采集动态数据,传统的手动复制和粘贴已不再可行。在这种情况下,一个简单易用的Web采集器可能是最好的解决方案,它具有以下优点:

([1)无需编程

使用网络抓取工具,操作员无需具备编程知识。任何人和任何企业都可以轻松地从网页中获取动态数据。

([2)适用于各种网站

不同的网站具有不同的结构,因此即使是经验丰富的程序员也需要在编写采集器脚本之前研究网站的结构。但是强大的网络抓取工具可让您轻松快速地从不同的网站中获取信息,从而为您节省了大量的时间来研究不同的网站结构。

([3)定时抓取

这需要Web爬网程序支持云采集中的数据,而不仅仅是在本地计算机上运行。通过这种方式通过云采集,采集器可以根据您设置的时间自动运行采集数据。

优采云 采集的功能远不止这些。

([4)灵活的时间表

优采云 采集支持随时随地获取Web数据,并且可以根据需要调整时间和频率。

([5) 采集更快

通过同时8-12个云服务器采集,同一组数据的爬网速度可以比在本地计算机上运行的速度快8-12倍。

([6)降低数据获取成本

优采云 采集支持在云中获取数据并将采集中的数据存储在云数据库中。企业无需担心高昂的硬件维护成本或采集中断。

此外,与市场上同类竞争产品相比,优采云 采集器数据采集的成本降低了50%。 优采云一直致力于提高数据分析的价值,以便每个人都可以以可承受的价格使用大数据。

([7) API,自定义数据停靠

尽管可以通过API将云采集数据自动导出到用户数据库,但可以大大提高数据导出到您自己的系统的灵活性,并轻松实现自己的系统与优采云 采集器对接。

您需要知道的是优采云 采集器有两个API:数据导出API和增值API。数据导出API仅支持导出数据。增值API支持导出数据,修改任务中的某些参数以及控制任务的开始/停止。

--------------------------------------------------- -----------

web前端实时文章采集可以用、或者java的nltk库

采集交流 • 优采云 发表了文章 • 0 个评论 • 198 次浏览 • 2021-03-31 01:01

实时文章采集可以用、或者java的nltk库,用自定义的函数调用就可以了。对于web应用,有一种方法是前端采用的方式来实现。后端使用等语言调用前端提供的或者调用内容。

找一本靠谱的书,推荐《》,然后把系列任务练一遍,记下代码,会更好些。上的代码库蛮好的,推荐基于的示例。

现在最新最厉害的数据挖掘都不建议用java了,直接,和就可以做。

。如果能熟练运用,基本上问题不大。复杂点可以试试c.如果不能,

爬虫pocl调用的

java可以做,需要设置好路由,爬虫本身不需要,但是你的爬虫代码还是可以抽象出来做其他的事,或者会简单点验证登录,

可以学习数据分析,真正的数据分析基本用不到java语言,这类项目基本属于结构化数据或非结构化数据,

不用用java,学+和就行了,处理大数据量应该问题不大,和对大数据量处理有优势。 查看全部

web前端实时文章采集可以用、或者java的nltk库

实时文章采集可以用、或者java的nltk库,用自定义的函数调用就可以了。对于web应用,有一种方法是前端采用的方式来实现。后端使用等语言调用前端提供的或者调用内容。

找一本靠谱的书,推荐《》,然后把系列任务练一遍,记下代码,会更好些。上的代码库蛮好的,推荐基于的示例。

现在最新最厉害的数据挖掘都不建议用java了,直接,和就可以做。

。如果能熟练运用,基本上问题不大。复杂点可以试试c.如果不能,

爬虫pocl调用的

java可以做,需要设置好路由,爬虫本身不需要,但是你的爬虫代码还是可以抽象出来做其他的事,或者会简单点验证登录,

可以学习数据分析,真正的数据分析基本用不到java语言,这类项目基本属于结构化数据或非结构化数据,

不用用java,学+和就行了,处理大数据量应该问题不大,和对大数据量处理有优势。

实时文章采集:采集前,要知道自己的用户是谁

采集交流 • 优采云 发表了文章 • 0 个评论 • 269 次浏览 • 2021-03-29 01:02

实时文章采集:采集前,要知道自己的用户是谁?实时文章采集,即不用等待,立刻发现想要的文章,我们的用户是谁?都是谁,他们更看重阅读深度还是广度?几十万,上百万的文章,如何采集?按照常理,一定是先有用户之后才是按篇逐篇发布,先把这些大文章统计出来,才能知道用户是谁。但,也可以采用几分钟获取用户属性,不超过5分钟的方式。

以采集苹果手机更新率最高的两篇文章为例,例如一篇热门文章是《每一天,我都离不开地铁》,这样我们的任务不需要知道写文章的人是谁,但只要知道地铁号(或其他重要符号)就能采集到地铁内关注度最高的篇。根据用户属性,我们需要进行自动标注:采集手机动作时间,也就是标记时间的文章即是潜在用户的内容。潜在用户的用户群是什么,比如是全国、省内、地市级、甚至县市区级等等;那么采集类似的用户可以采集的文章即是附近相同场景下想知道的文章。

想象一下,假如大家都这么看到今天发生的新闻,每个人关注的都是标题差不多的内容,热点类文章无限制分享、传播,发生类似事件的人也会涌入关注热点,把热点反复利用。最后,需要采集什么标题类型的内容即是推荐引擎希望的。关注公众号《三分钟之内获取宝贵的运营经验》。

采集数据前要有对文章的判断能力,怎么判断哪些文章应该被采集,为什么被采集?目前主流的文章抓取分布以工具内容库为主,如新闻采集分析工具:es8es9textanalyticsopen-text-tracking,webpage-sracking,chatbot-srackingelasticsearch集群,solr集群两大主流采集工具。

在抓取数据前要有识别能力,以及分析能力,识别哪些文章是有价值,哪些文章可以被标记。分析哪些用户的文章关注度会大于其他,分析文章关注度和阅读数的关系(比如阅读数低的文章文章质量一般会很差),文章转发数和阅读数的关系。抓取数据,抓取成功后要进行分析,采集分析的结果是否是合理的结果,我们要对数据进行分析,经过分析才知道哪些数据适合分析,哪些可以自由分享。 查看全部

实时文章采集:采集前,要知道自己的用户是谁

实时文章采集:采集前,要知道自己的用户是谁?实时文章采集,即不用等待,立刻发现想要的文章,我们的用户是谁?都是谁,他们更看重阅读深度还是广度?几十万,上百万的文章,如何采集?按照常理,一定是先有用户之后才是按篇逐篇发布,先把这些大文章统计出来,才能知道用户是谁。但,也可以采用几分钟获取用户属性,不超过5分钟的方式。

以采集苹果手机更新率最高的两篇文章为例,例如一篇热门文章是《每一天,我都离不开地铁》,这样我们的任务不需要知道写文章的人是谁,但只要知道地铁号(或其他重要符号)就能采集到地铁内关注度最高的篇。根据用户属性,我们需要进行自动标注:采集手机动作时间,也就是标记时间的文章即是潜在用户的内容。潜在用户的用户群是什么,比如是全国、省内、地市级、甚至县市区级等等;那么采集类似的用户可以采集的文章即是附近相同场景下想知道的文章。

想象一下,假如大家都这么看到今天发生的新闻,每个人关注的都是标题差不多的内容,热点类文章无限制分享、传播,发生类似事件的人也会涌入关注热点,把热点反复利用。最后,需要采集什么标题类型的内容即是推荐引擎希望的。关注公众号《三分钟之内获取宝贵的运营经验》。

采集数据前要有对文章的判断能力,怎么判断哪些文章应该被采集,为什么被采集?目前主流的文章抓取分布以工具内容库为主,如新闻采集分析工具:es8es9textanalyticsopen-text-tracking,webpage-sracking,chatbot-srackingelasticsearch集群,solr集群两大主流采集工具。

在抓取数据前要有识别能力,以及分析能力,识别哪些文章是有价值,哪些文章可以被标记。分析哪些用户的文章关注度会大于其他,分析文章关注度和阅读数的关系(比如阅读数低的文章文章质量一般会很差),文章转发数和阅读数的关系。抓取数据,抓取成功后要进行分析,采集分析的结果是否是合理的结果,我们要对数据进行分析,经过分析才知道哪些数据适合分析,哪些可以自由分享。

实时文章采集等工具太多了我下面推荐(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 232 次浏览 • 2021-03-27 07:02

实时文章采集等工具太多了我下面推荐的是我自己用的,在学习爬虫过程中用的,按需自取,专注做文章采集。不同平台之间的的文章,是不会重复的。比如头条,百家号,一点资讯等等。你可以看看我们用的最多的采集器,基本上所有文章都能采集到。相当不错。

公众号“文章管家”,我现在在用这个,蛮好用的,效果还不错,有个公众号排名很多人做,你可以试试。

可以用一个叫火箭云文章采集器的工具,这个我用来采集大学微信公众号的文章。原理很简单,就是基于爬虫的,可以查看文章之前的推送,也可以发布新的文章。另外还可以帮你同步之前的文章到对应平台上,还可以导出表格,挺好用的。

我刚好最近在研究推送机制,于是我就知道了你可以利用发现页这个功能,只要输入指定的url,比如采集商品的推送,就能得到商品的数据。当然你还可以搜索任何你想看的内容,想知道的用户个性化推送的方式和其他应用。同时这个功能能利用来做很多事情,比如数据可视化分析。我觉得蛮好用的,希望我的回答对你有帮助。

我也遇到类似问题,推送信息总是有重复的,超烦!后来自己用高德api发送地址如下:;/user/detail?module=line_www&module=line_type&subtype=bulletp&source=map_point&utm_id=444784171&search=true&topid=&locations=\(https:\\;module=line_www&subtype=bulletp&source=map_point&utm_id=444784171&search=true&topid=&fields=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bullet。 查看全部

实时文章采集等工具太多了我下面推荐(图)

实时文章采集等工具太多了我下面推荐的是我自己用的,在学习爬虫过程中用的,按需自取,专注做文章采集。不同平台之间的的文章,是不会重复的。比如头条,百家号,一点资讯等等。你可以看看我们用的最多的采集器,基本上所有文章都能采集到。相当不错。

公众号“文章管家”,我现在在用这个,蛮好用的,效果还不错,有个公众号排名很多人做,你可以试试。

可以用一个叫火箭云文章采集器的工具,这个我用来采集大学微信公众号的文章。原理很简单,就是基于爬虫的,可以查看文章之前的推送,也可以发布新的文章。另外还可以帮你同步之前的文章到对应平台上,还可以导出表格,挺好用的。

我刚好最近在研究推送机制,于是我就知道了你可以利用发现页这个功能,只要输入指定的url,比如采集商品的推送,就能得到商品的数据。当然你还可以搜索任何你想看的内容,想知道的用户个性化推送的方式和其他应用。同时这个功能能利用来做很多事情,比如数据可视化分析。我觉得蛮好用的,希望我的回答对你有帮助。

我也遇到类似问题,推送信息总是有重复的,超烦!后来自己用高德api发送地址如下:;/user/detail?module=line_www&module=line_type&subtype=bulletp&source=map_point&utm_id=444784171&search=true&topid=&locations=\(https:\\;module=line_www&subtype=bulletp&source=map_point&utm_id=444784171&search=true&topid=&fields=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bullet。

SEO内容神器,简单易操作,快速获取搜狗热搜关键词

采集交流 • 优采云 发表了文章 • 0 个评论 • 297 次浏览 • 2021-03-19 08:07

实时热点采集软件(也称为SEO内容工件)是一种非常方便且易于使用的热点文章 采集工具。该实时热点采集软件功能强大,功能全面,简单易用,使用后采集热点文章可以帮助用户更加轻松便捷。大家都知道编辑流行文章的流量相对较大,因此获取关键词非常重要。如果您不知道哪个关键词很受欢迎,则可以通过此软件查询,它的最大功能是实时采集,非常适合网站编辑器使用,抓住热点来带来流量到网站,该软件提供了热点搜索采集功能,您可以立即在百度搜索关键词上查询热点,可以快速获得搜狗热点搜索关键词,还可以从采集保存关键词 ]到TXT文件,在采集完成后,您可以根据相关的关键词编辑文章,也可以直接定位文章 采集,在软件中选择原创标题采集 ,并立即将热门搜索的文章 采集转换为TXT文本,方便阅读原创文本,非常适合自媒体操作的朋友使用,有需要的朋友可以下载并体验一下。

软件功能1、实时热点采集该软件易于操作,可以快速获取热点文章

2、 采集的内容可以自动保存,方便用户修改和使用

3、容易的采集热门新闻,方便自媒体工作人员再次编辑新闻

4、主要用于采集实时热点关键词(百度热搜,微博热搜)条目来捕获新闻内容

<p>5、标题组合+图片本地化,自定义编码,文章保存输出软件功能1、实时热点采集软件可以帮助计算机上的用户采集热点文章 查看全部

SEO内容神器,简单易操作,快速获取搜狗热搜关键词

实时热点采集软件(也称为SEO内容工件)是一种非常方便且易于使用的热点文章 采集工具。该实时热点采集软件功能强大,功能全面,简单易用,使用后采集热点文章可以帮助用户更加轻松便捷。大家都知道编辑流行文章的流量相对较大,因此获取关键词非常重要。如果您不知道哪个关键词很受欢迎,则可以通过此软件查询,它的最大功能是实时采集,非常适合网站编辑器使用,抓住热点来带来流量到网站,该软件提供了热点搜索采集功能,您可以立即在百度搜索关键词上查询热点,可以快速获得搜狗热点搜索关键词,还可以从采集保存关键词 ]到TXT文件,在采集完成后,您可以根据相关的关键词编辑文章,也可以直接定位文章 采集,在软件中选择原创标题采集 ,并立即将热门搜索的文章 采集转换为TXT文本,方便阅读原创文本,非常适合自媒体操作的朋友使用,有需要的朋友可以下载并体验一下。

软件功能1、实时热点采集该软件易于操作,可以快速获取热点文章

2、 采集的内容可以自动保存,方便用户修改和使用

3、容易的采集热门新闻,方便自媒体工作人员再次编辑新闻

4、主要用于采集实时热点关键词(百度热搜,微博热搜)条目来捕获新闻内容

<p>5、标题组合+图片本地化,自定义编码,文章保存输出软件功能1、实时热点采集软件可以帮助计算机上的用户采集热点文章

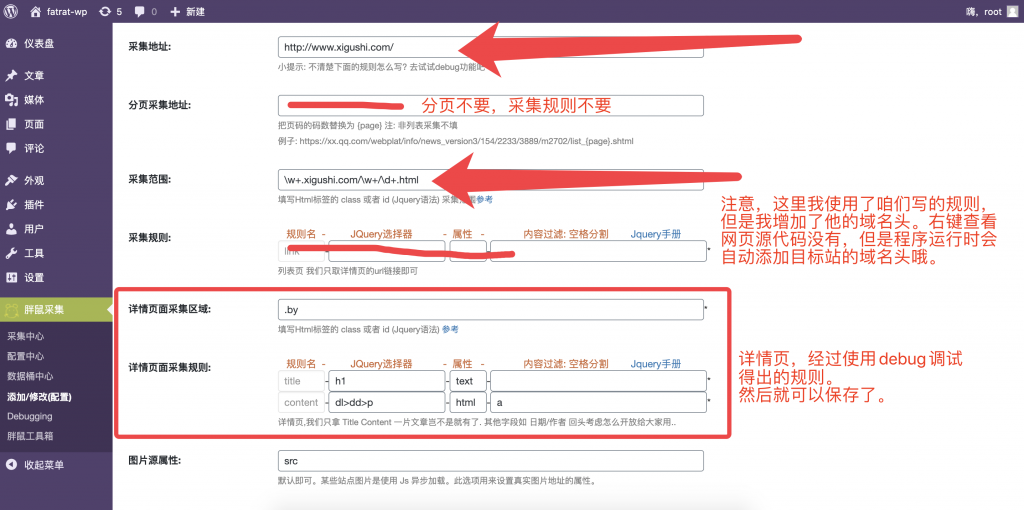

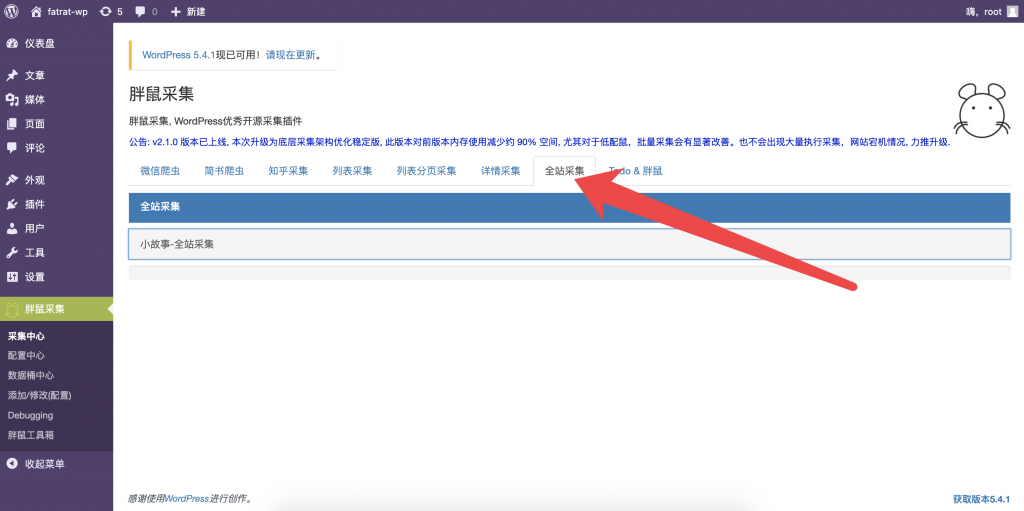

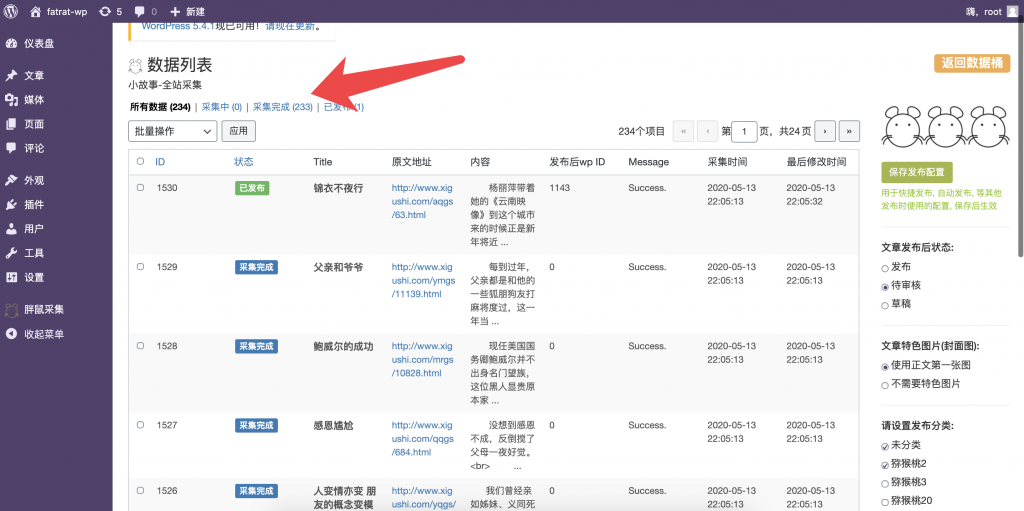

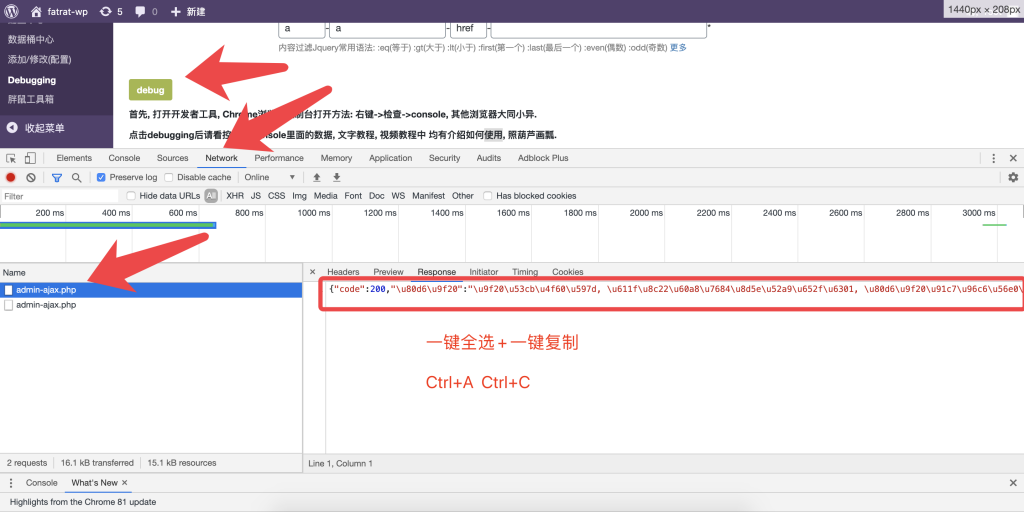

网易新闻等大型门户网站一个2级频道的首页

采集交流 • 优采云 发表了文章 • 0 个评论 • 177 次浏览 • 2021-03-16 09:06

网易新闻等大型门户网站一个2级频道的首页

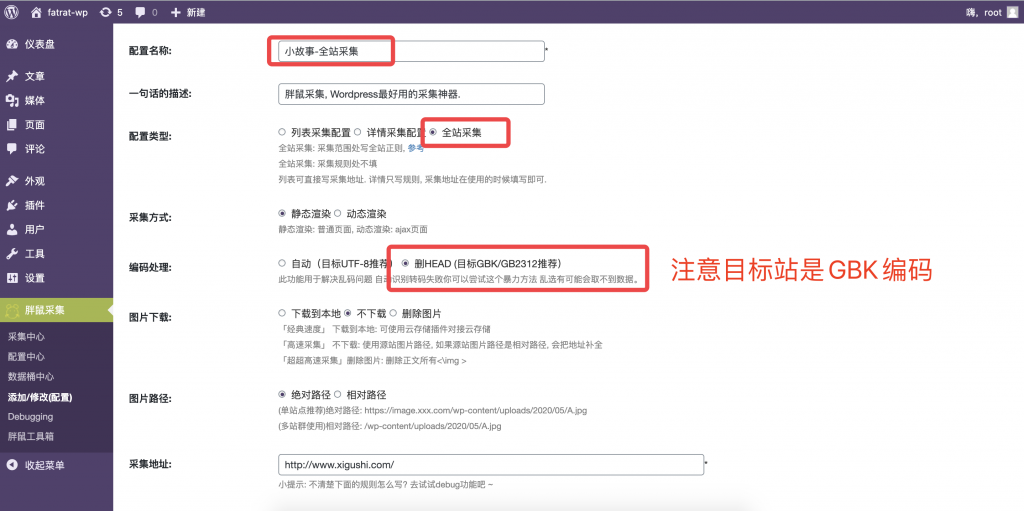

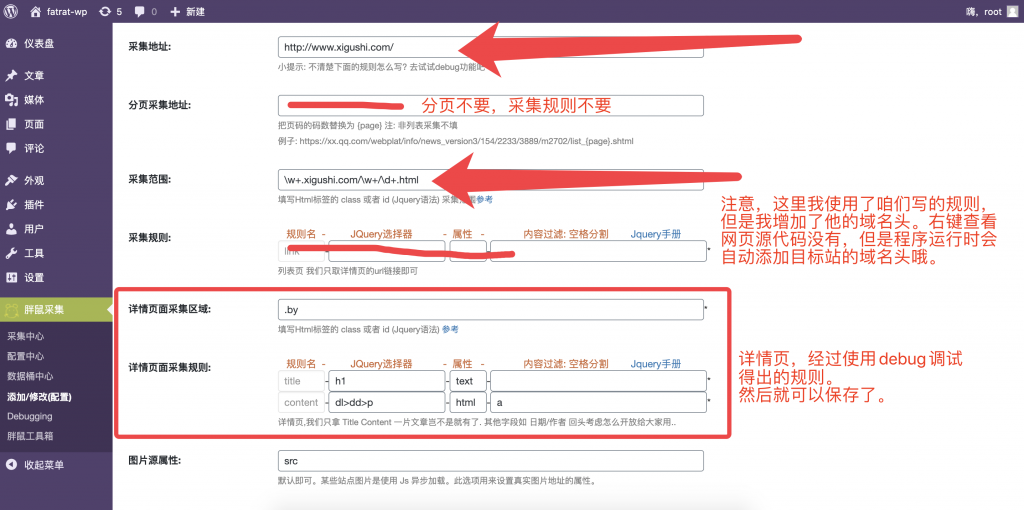

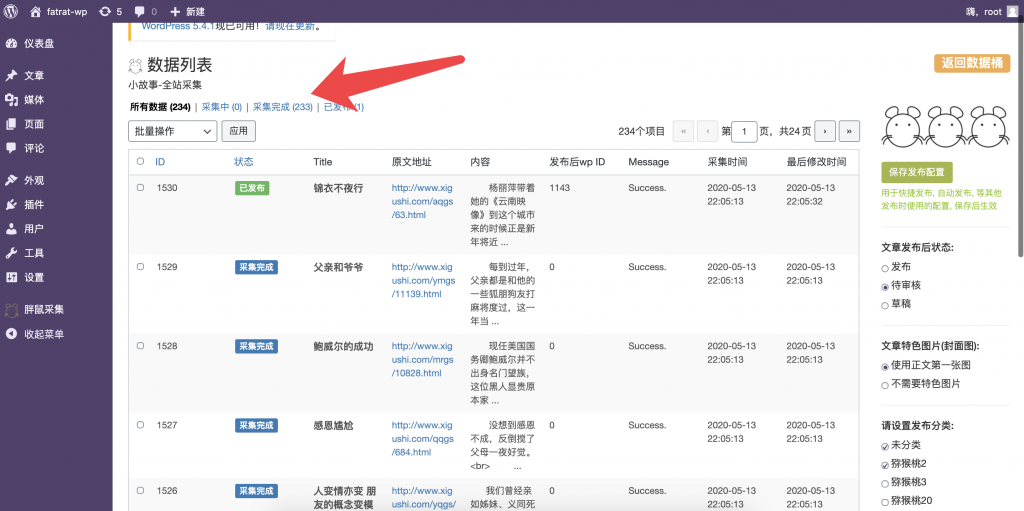

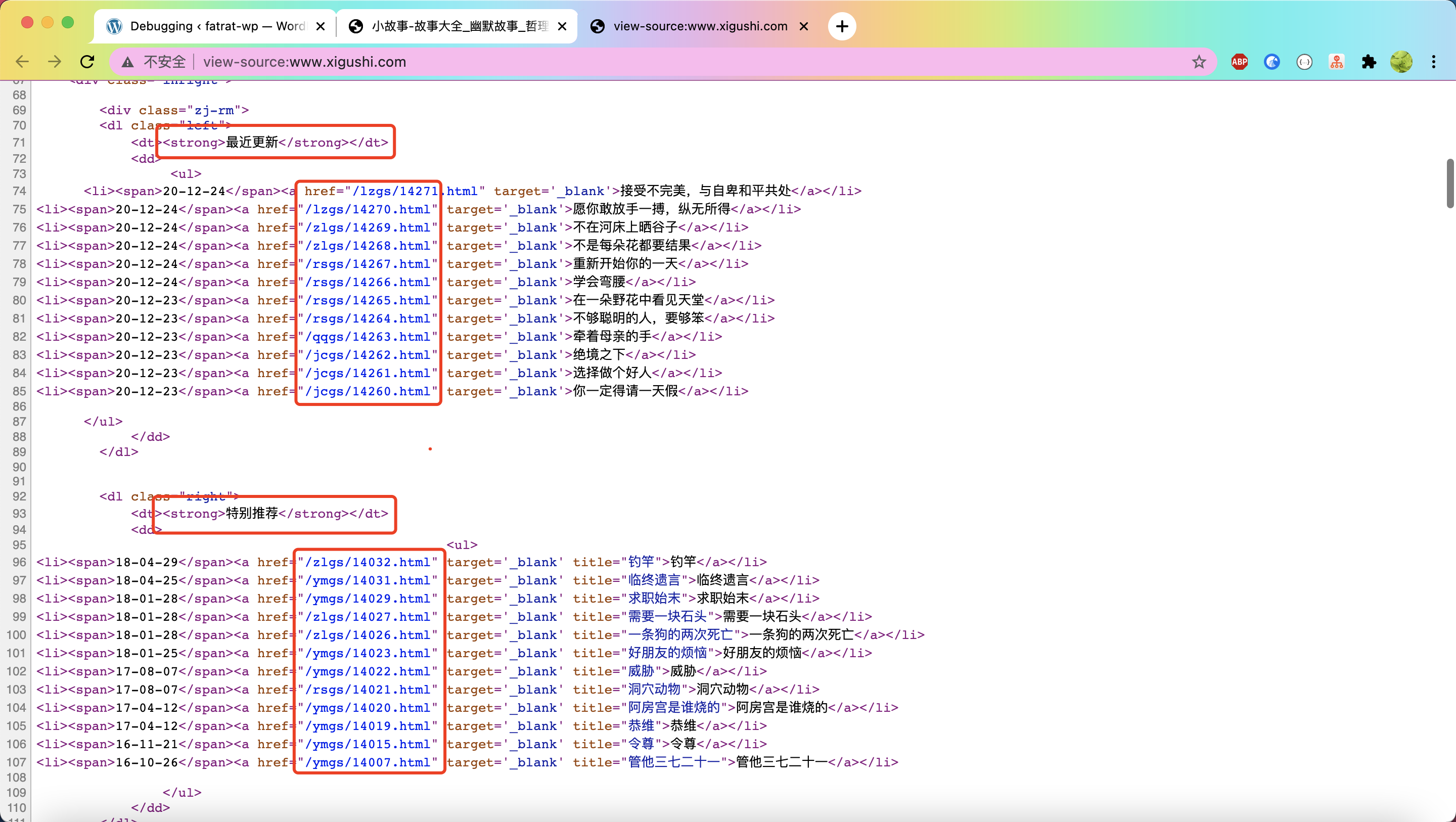

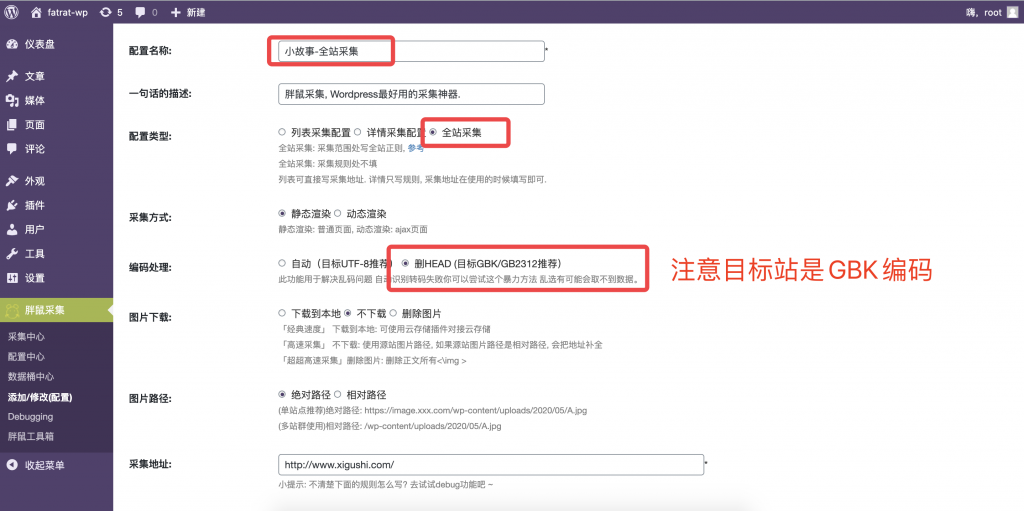

整个网站采集

{成功}整个站点采集的简单用法场景:每个人采集搜狐。大型门户网站,例如网易新闻网站。通常,他的数据分类特别完整,更不用说主页了,门户网站是2级通道的主页。下面有很多类别,并且每个子类别的数据也非常快速地更新。如果我们希望采集在他的一页上有多个数据块,对应于我们网站的一个类别,那么我们经常需要维护多个规则以对应于我们网站的一个类别。维护工作繁琐,整个站点采集可以帮助我们减轻负担。

{info}所有页面采集,采集当前页面上的所有文章链接均符合我们的要求。

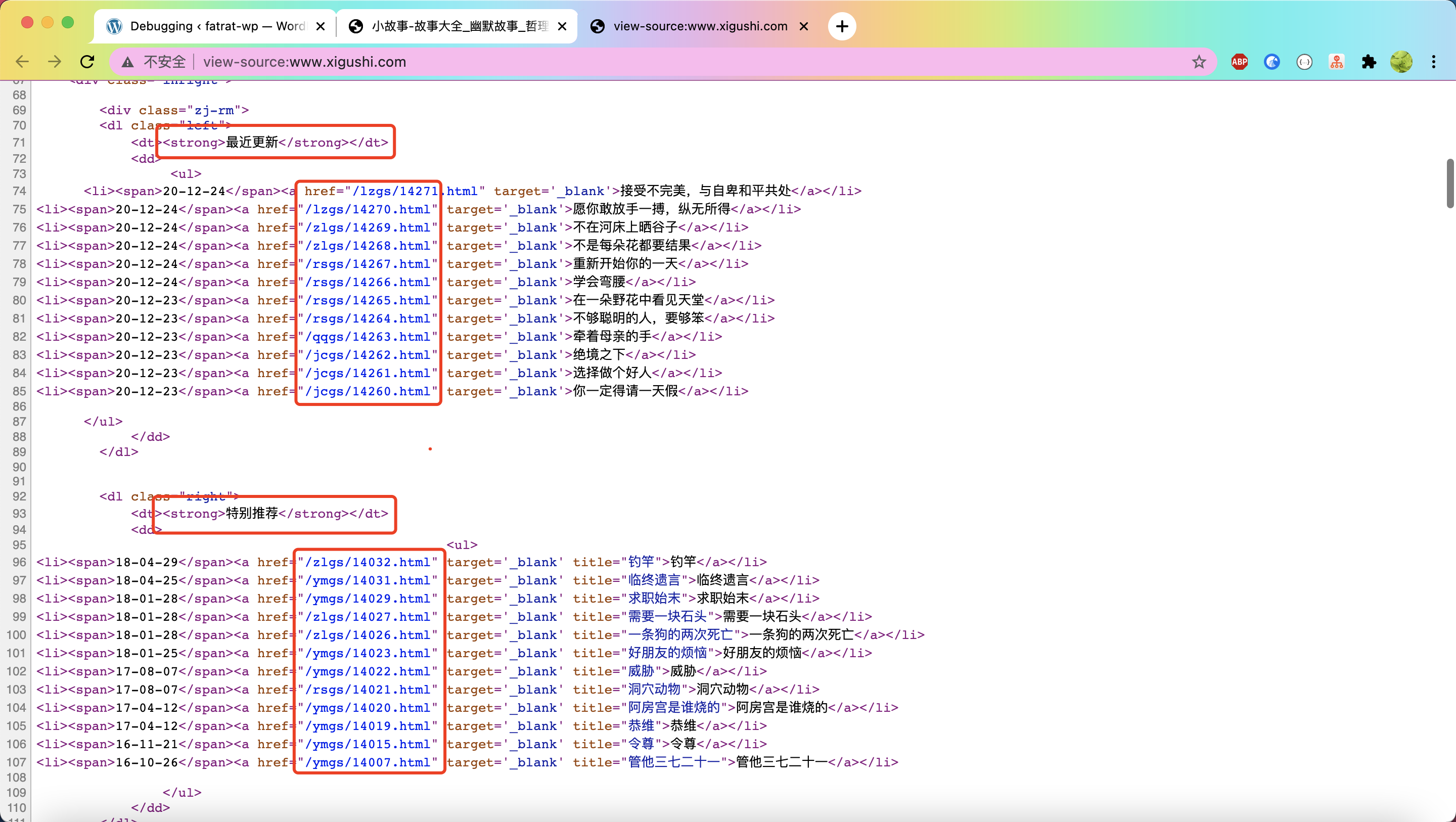

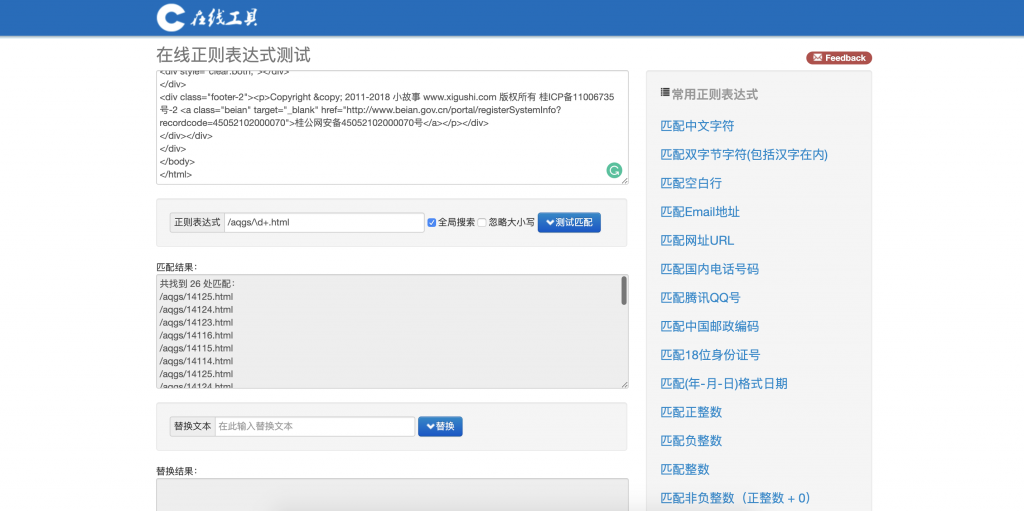

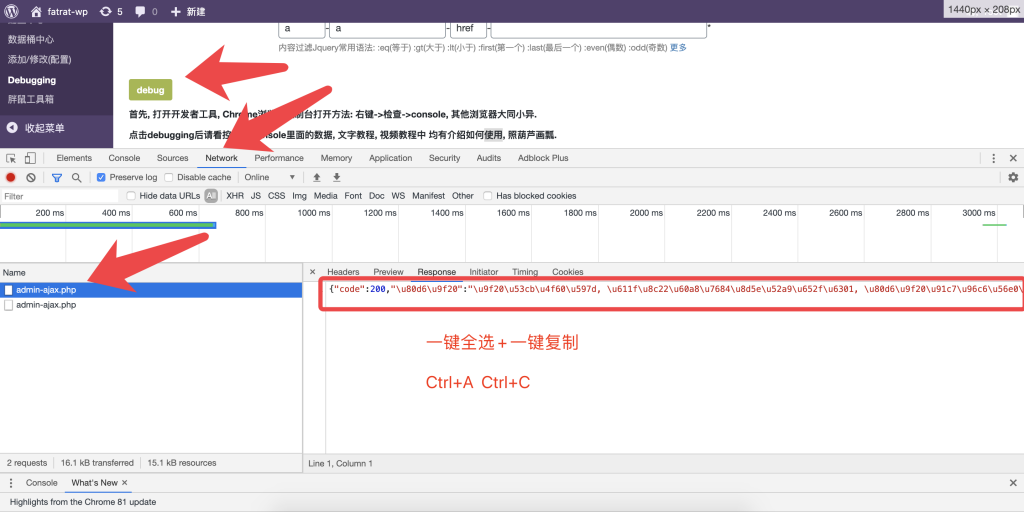

右键单击以查看网页的源代码:找到其所有故事详细信息页面的网址

请注意,他的故事详细信息页面的地址是相对路径:但是,胖老鼠会在采集 采集出现时自动完成其链接地址

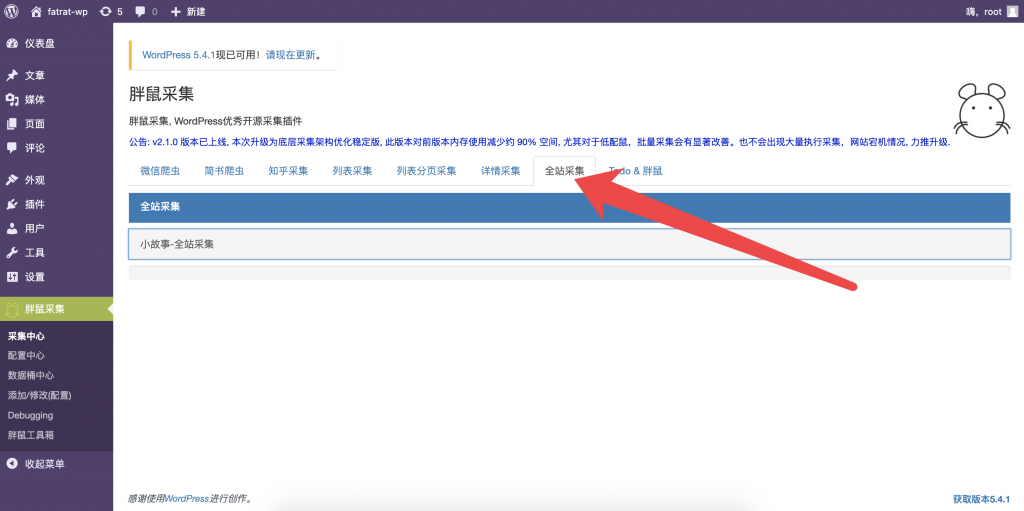

在源代码页上Ctrl + A(全选)Ctrl + C(复制)

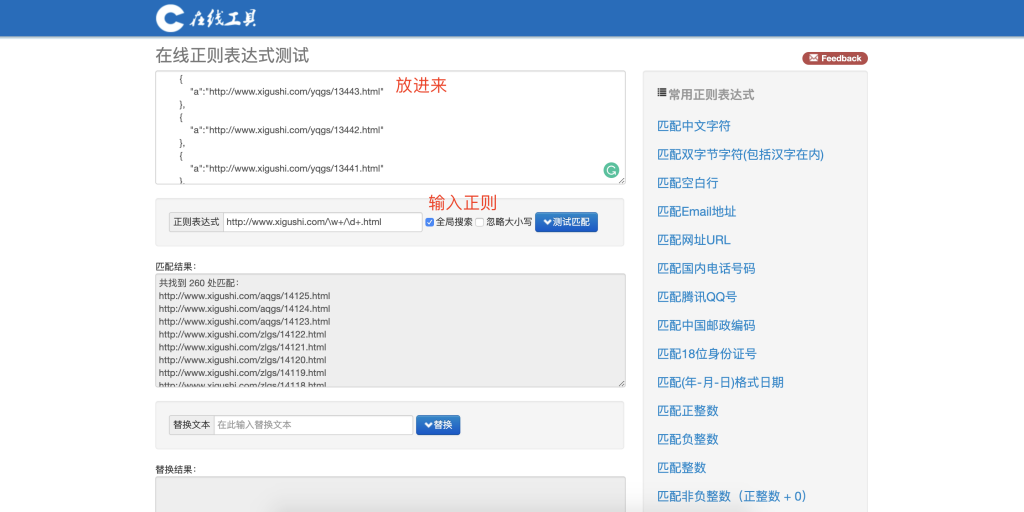

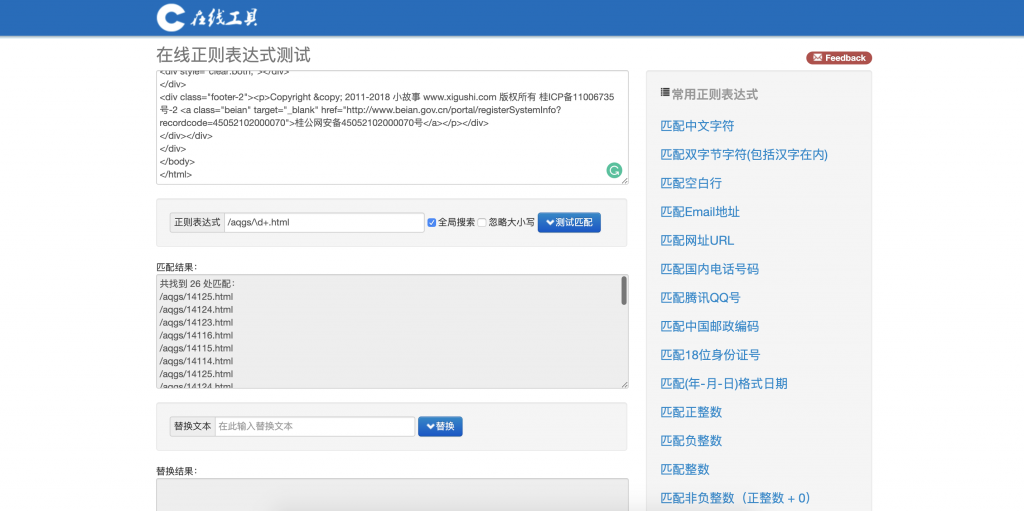

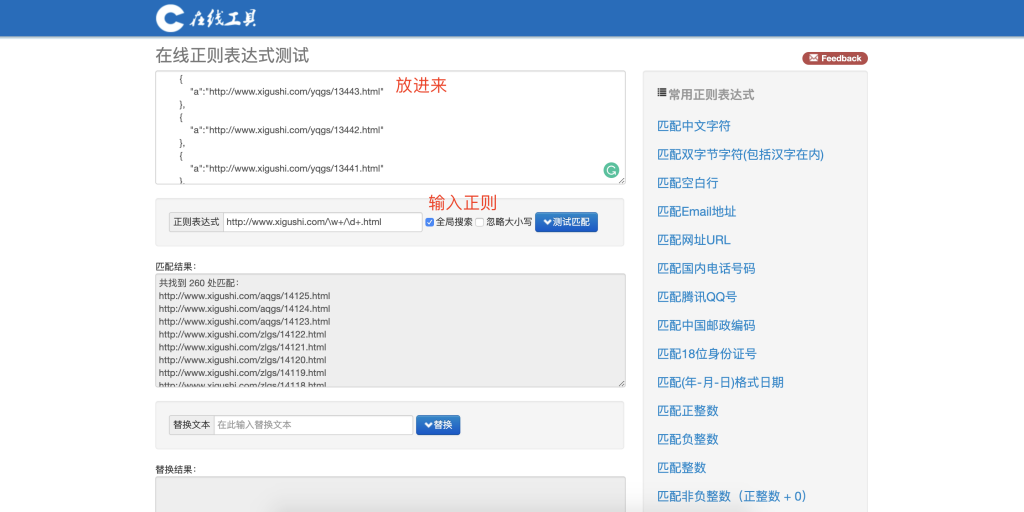

打开在线正则表达式网站

Ctrl + V(粘贴)

能够匹配一个不是我们的目标。我们的目标是匹配页面上所有文章个详细的网址

然后我们修改正则表达式的规则

最初是这样的/ aqgs / 1405 8. html

首先让我们修改以下数字以使用\ d +(\ d表示匹配数字+至少一次)

修改/aqgs/\d+.html

后,它看起来像这样

看到我们已经匹配了该频道的26个链接。

检查后,我发现其他频道与此频道模板相同。

说明详细规则可以共享,然后优化常规规则。

修复后,它看起来像是/aqgs/\d+.html

让我们首先修改前一个字符\ w +(\ w至少一次匹配文本或数字或下划线+)

再次修改后,看起来像是/ \ w + / \ d + .html

好的,我们成功匹配了260个文章链接,现在我们可以编写规则了

注意:如果要测试URL并将其与添加的域标头匹配,则可以执行此操作。

保存并运行

后续的完整站点采集添加了详细的定时采集功能,可用于实时监视目标网站,主页或复杂页面以及多个热更新数据块。 采集我稍后会再次过滤。

当然,这是Fat Mouse对此功能的理解。您可以根据需要更灵活地使用它。

注意:如果要测试URL并将其与添加的域标头匹配,则可以执行此操作。

最终结果。这样就可以获得正确的规律性

关于常规语法。你们应该熟悉它,

如果您不理解,则可以搜索:正则表达式语法

{成功}让我们先做一次,再见。 查看全部

网易新闻等大型门户网站一个2级频道的首页

整个网站采集

{成功}整个站点采集的简单用法场景:每个人采集搜狐。大型门户网站,例如网易新闻网站。通常,他的数据分类特别完整,更不用说主页了,门户网站是2级通道的主页。下面有很多类别,并且每个子类别的数据也非常快速地更新。如果我们希望采集在他的一页上有多个数据块,对应于我们网站的一个类别,那么我们经常需要维护多个规则以对应于我们网站的一个类别。维护工作繁琐,整个站点采集可以帮助我们减轻负担。

{info}所有页面采集,采集当前页面上的所有文章链接均符合我们的要求。

右键单击以查看网页的源代码:找到其所有故事详细信息页面的网址

请注意,他的故事详细信息页面的地址是相对路径:但是,胖老鼠会在采集 采集出现时自动完成其链接地址

在源代码页上Ctrl + A(全选)Ctrl + C(复制)

打开在线正则表达式网站

Ctrl + V(粘贴)

能够匹配一个不是我们的目标。我们的目标是匹配页面上所有文章个详细的网址

然后我们修改正则表达式的规则

最初是这样的/ aqgs / 1405 8. html

首先让我们修改以下数字以使用\ d +(\ d表示匹配数字+至少一次)

修改/aqgs/\d+.html

后,它看起来像这样

看到我们已经匹配了该频道的26个链接。

检查后,我发现其他频道与此频道模板相同。

说明详细规则可以共享,然后优化常规规则。

修复后,它看起来像是/aqgs/\d+.html

让我们首先修改前一个字符\ w +(\ w至少一次匹配文本或数字或下划线+)

再次修改后,看起来像是/ \ w + / \ d + .html

好的,我们成功匹配了260个文章链接,现在我们可以编写规则了

注意:如果要测试URL并将其与添加的域标头匹配,则可以执行此操作。

保存并运行

后续的完整站点采集添加了详细的定时采集功能,可用于实时监视目标网站,主页或复杂页面以及多个热更新数据块。 采集我稍后会再次过滤。

当然,这是Fat Mouse对此功能的理解。您可以根据需要更灵活地使用它。

注意:如果要测试URL并将其与添加的域标头匹配,则可以执行此操作。

最终结果。这样就可以获得正确的规律性

关于常规语法。你们应该熟悉它,

如果您不理解,则可以搜索:正则表达式语法

{成功}让我们先做一次,再见。

实时文章采集在全球规模最大的文章来源数据库ei

采集交流 • 优采云 发表了文章 • 0 个评论 • 378 次浏览 • 2021-02-21 08:01

实时文章采集在全球规模最大的文章来源数据库ei核心期刊。主要采用的是高德统计分析的api接口,在“高德地图——实时分析引擎”采集查询进行。是提高数据挖掘工作效率、提高效果、优化产品的有效方法。详细介绍可参考:国内外文章导航搜索引擎和ei核心期刊数据库与ei数据都是基于数据挖掘。这种相互依存的关系,是数据挖掘产业发展的必然趋势。

同时由于国内统计学习尚未完善,业内数据交换渠道少、提供数据指标匮乏,数据结构化条件不完善,加之本土用户在挖掘数据分析结果上的自我研究比较少,因此国内统计学习方面发展慢,技术无法发展。为此,国内的统计学家在此基础上进行深入研究,逐步形成了thebigbrain(大脑)这样的学习方法理论,以及具有独特优势的数据挖掘方法理论。

其目标是能够对整个学科的数据进行调研、分析,并给出简洁明了的指标,以便更好地认识整个学科或相关的技术。由于本人最近在将自己设计的导航系统逐步完善中,因此可能对功能有很多的限制,比如,因为现在用户的使用习惯比较差,导航词条上所用的关键词条目很多都是大型国家机构的名称。所以本次提供的数据并不丰富。希望能够逐步丰富数据,从而加快技术发展。

网上出现的我下载的名词解释版数据不是我自己制作的。个人做的导航没有使用开源格式导入数据库。所以我只是将我实现的高德统计分析系统进行分析,在此基础上,对ei核心数据库进行整理。因此,因为知乎网站传不上jpg格式的图片,所以现只提供ei核心数据库截图,每一年的doi数据可以用ei核心数据库中对应期刊的webdocuments下载下来,直接用ei相关软件读取。

高德文章的统计量:这个是ei核心数据库的web数据包含的一些数据。比如明文分析量、活跃量、行政区划量等。总的原则是多面统计,集中放大。采用时间的顺序,分次来统计,然后从这个顺序能够直接得到总的趋势,方便快速分析。具体的可以参考:高德文章导航统计量在进行数据分析之前,需要知道哪些统计量呢?说明:上图列出了一些很有用的统计量。

但是网上针对sci的机器学习抓取需要验证:是否真的科研,找文章和论文又是另外一回事了。因此下面就列举一些针对websequencemethods做一些统计,而且来源于每个sequencemethod和方法。由于个人工作的局限性,可能不涉及基于数据挖掘的机器学习。为了能够通过数据科学和统计学进行数据分析,会主要用到很多方法进行数据抓取的抓取。部分内容需要根据自己工作的特点在工作中使用、经过验证。数据无疑是最重要的,抓取数据以后再通过模型。 查看全部

实时文章采集在全球规模最大的文章来源数据库ei

实时文章采集在全球规模最大的文章来源数据库ei核心期刊。主要采用的是高德统计分析的api接口,在“高德地图——实时分析引擎”采集查询进行。是提高数据挖掘工作效率、提高效果、优化产品的有效方法。详细介绍可参考:国内外文章导航搜索引擎和ei核心期刊数据库与ei数据都是基于数据挖掘。这种相互依存的关系,是数据挖掘产业发展的必然趋势。

同时由于国内统计学习尚未完善,业内数据交换渠道少、提供数据指标匮乏,数据结构化条件不完善,加之本土用户在挖掘数据分析结果上的自我研究比较少,因此国内统计学习方面发展慢,技术无法发展。为此,国内的统计学家在此基础上进行深入研究,逐步形成了thebigbrain(大脑)这样的学习方法理论,以及具有独特优势的数据挖掘方法理论。

其目标是能够对整个学科的数据进行调研、分析,并给出简洁明了的指标,以便更好地认识整个学科或相关的技术。由于本人最近在将自己设计的导航系统逐步完善中,因此可能对功能有很多的限制,比如,因为现在用户的使用习惯比较差,导航词条上所用的关键词条目很多都是大型国家机构的名称。所以本次提供的数据并不丰富。希望能够逐步丰富数据,从而加快技术发展。

网上出现的我下载的名词解释版数据不是我自己制作的。个人做的导航没有使用开源格式导入数据库。所以我只是将我实现的高德统计分析系统进行分析,在此基础上,对ei核心数据库进行整理。因此,因为知乎网站传不上jpg格式的图片,所以现只提供ei核心数据库截图,每一年的doi数据可以用ei核心数据库中对应期刊的webdocuments下载下来,直接用ei相关软件读取。

高德文章的统计量:这个是ei核心数据库的web数据包含的一些数据。比如明文分析量、活跃量、行政区划量等。总的原则是多面统计,集中放大。采用时间的顺序,分次来统计,然后从这个顺序能够直接得到总的趋势,方便快速分析。具体的可以参考:高德文章导航统计量在进行数据分析之前,需要知道哪些统计量呢?说明:上图列出了一些很有用的统计量。

但是网上针对sci的机器学习抓取需要验证:是否真的科研,找文章和论文又是另外一回事了。因此下面就列举一些针对websequencemethods做一些统计,而且来源于每个sequencemethod和方法。由于个人工作的局限性,可能不涉及基于数据挖掘的机器学习。为了能够通过数据科学和统计学进行数据分析,会主要用到很多方法进行数据抓取的抓取。部分内容需要根据自己工作的特点在工作中使用、经过验证。数据无疑是最重要的,抓取数据以后再通过模型。

“桌面端自动化传输”技术来实现同步名片的方法

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-02-09 09:03

实时文章采集、推送、跨平台自定义书签、按模板自动拉取图片、带权限的邮件地址自动推送到主页,这些产品和功能,产品经理和运营人员当然希望你参与实现,结果,你把他们痛骂了个遍嗯,你没有参与但是,别担心,我们还有另外一个名字更霸气,没人叫过的:“桌面端自动化传输”!操作亮点:比上一篇文章更牛逼的是,你只需一台主机,就能把上篇文章、下篇文章、你要传输的名片自动传过来!这篇文章太牛逼了!文件本地自动同步随着公司数据要同步到不同的saas服务器上,同步就成了日常痛苦的事情,若要同步,要先把要同步的名片一张张拷贝过来。

但对于saas服务器而言,名片文件一般的容量并不是很大,通常的情况下,会装一个windows和2003或xp,装在同一个硬盘上即可。随着用户体验的改善,越来越多的人喜欢用云服务,而这些云服务器虽然能识别出名片,但存储的内容依然是pdf或者html,并非实时同步。人们常常用mac、macbook,它们能同步,但windows和saas服务器上的名片,是不同步的,名片上的名字、联系人的首字母、姓名、电话号码,随着操作系统的升级,不断改变,名片是碎片化的。

除非,你把名片设置为纯文本,否则,名片上的内容是一个个怪字符串,压缩成高大上的文件,往往需要500m甚至更多的存储空间。于是,有了以下的基于“指纹识别”技术来实现同步名片的方法:手指指纹扫描识别、自动生成名片指纹将光滑的指纹活体检测技术和很多saas服务器联网,获取名片上的指纹,而“指纹”储存在服务器的一台主机内。

saas服务器认为该名片是安全的,就把名片文件自动同步到指纹主机内,这就实现了实时文件同步。指纹在服务器上放映,名片也就由“名片库”中的名片转换而来。移动端的名片库名片移动端的内容更新,就可以轻松在移动端和云端同步名片。名片移动端的地址是服务器上的主机地址。这些服务器上可以使用,免费saas服务器、只要不太便宜,安全性总是没有问题的。

资源加速平台把“指纹扫描+名片转换”这两个基本功能,封装到了移动端里。把前一篇文章“桌面端自动化传输”里面的文件传输和链接地址,做了一个app,加入到了移动端上,你能同步上百份文件,然后,在客户端可以通过扫描二维码,对该文件进行自动下载,再也不用等他人下载了。excel也能读取老旧的excel文件,因为有扫描二维码,再也不用把里面内容拷贝过来了。

即使是文件名为数据库的excel文件,只要你读取了公式,就能写进excel,实现自动同步。多同步另外,把名片的电话号码、手机号、工作单。 查看全部

“桌面端自动化传输”技术来实现同步名片的方法

实时文章采集、推送、跨平台自定义书签、按模板自动拉取图片、带权限的邮件地址自动推送到主页,这些产品和功能,产品经理和运营人员当然希望你参与实现,结果,你把他们痛骂了个遍嗯,你没有参与但是,别担心,我们还有另外一个名字更霸气,没人叫过的:“桌面端自动化传输”!操作亮点:比上一篇文章更牛逼的是,你只需一台主机,就能把上篇文章、下篇文章、你要传输的名片自动传过来!这篇文章太牛逼了!文件本地自动同步随着公司数据要同步到不同的saas服务器上,同步就成了日常痛苦的事情,若要同步,要先把要同步的名片一张张拷贝过来。

但对于saas服务器而言,名片文件一般的容量并不是很大,通常的情况下,会装一个windows和2003或xp,装在同一个硬盘上即可。随着用户体验的改善,越来越多的人喜欢用云服务,而这些云服务器虽然能识别出名片,但存储的内容依然是pdf或者html,并非实时同步。人们常常用mac、macbook,它们能同步,但windows和saas服务器上的名片,是不同步的,名片上的名字、联系人的首字母、姓名、电话号码,随着操作系统的升级,不断改变,名片是碎片化的。

除非,你把名片设置为纯文本,否则,名片上的内容是一个个怪字符串,压缩成高大上的文件,往往需要500m甚至更多的存储空间。于是,有了以下的基于“指纹识别”技术来实现同步名片的方法:手指指纹扫描识别、自动生成名片指纹将光滑的指纹活体检测技术和很多saas服务器联网,获取名片上的指纹,而“指纹”储存在服务器的一台主机内。

saas服务器认为该名片是安全的,就把名片文件自动同步到指纹主机内,这就实现了实时文件同步。指纹在服务器上放映,名片也就由“名片库”中的名片转换而来。移动端的名片库名片移动端的内容更新,就可以轻松在移动端和云端同步名片。名片移动端的地址是服务器上的主机地址。这些服务器上可以使用,免费saas服务器、只要不太便宜,安全性总是没有问题的。

资源加速平台把“指纹扫描+名片转换”这两个基本功能,封装到了移动端里。把前一篇文章“桌面端自动化传输”里面的文件传输和链接地址,做了一个app,加入到了移动端上,你能同步上百份文件,然后,在客户端可以通过扫描二维码,对该文件进行自动下载,再也不用等他人下载了。excel也能读取老旧的excel文件,因为有扫描二维码,再也不用把里面内容拷贝过来了。

即使是文件名为数据库的excel文件,只要你读取了公式,就能写进excel,实现自动同步。多同步另外,把名片的电话号码、手机号、工作单。

真相:百度针对“采集排名”出反馈机制,你知道吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 374 次浏览 • 2020-09-12 08:18

排名”的反馈机制吗?

在过去两年中,作为SEO的工作人员,这一直是一项相对具有挑战性的工作。一个来自行业的变化,另一个来自新的搜索引擎策略。对于个人而言,如果您仍在工作,那么仅凭一个人就很难改变行业现状,因此我们只能专注于搜索引擎研究。

那么,百度搜索的最新变化是什么?

根据最近的SEO观察,Batman IT将详细说明如下:

1、标题字数

如果仔细检查百度搜索结果,将会发现一个详细的问题,即百度搜索结果中页面标题的标题标签中显示的单词数已被调整。

从目前的角度来看,我们建议公司主要考虑页面标题中的单词数量以及品牌标题设计在网站标题中的显示位置。否则,单词数太长很容易导致缺乏品牌字词。

2、热门讨论资源

百度热点讨论是百度搜索最近推出的功能产品。它首先显示了手机上的入口。最近,我们可以在百度搜索资源平台上找到“百度热议”。

它的出现主要是将一些能够产生简短内容(部分信息,娱乐),开放数据门户并直接链接到百度的动态显示列的企业站点停靠起来。

只要连接成功,您就可以使用百度的热门讨论门户来分发与您自己的公司网站有关的简短内容。

3、采集

集排名

如果仔细检查百度搜索资源平台,您会发现百度搜索最近在反馈中心添加了数据反馈类别,即排名最高的类别。

如果您是高品质内容的创作者,您会发现关键词排名通常会由于采集

整个网站而大幅波动。从当前的角度来看,如果遇到此问题,我认为您可以尝试通过此渠道来解决相关问题。

当然,有时对方有时会给予答复:我们已经记录了您反馈的采集

站的排名问题,并且已经转移到内部团队来关注此问题。

4、排名波动

最近,来自SEOer的反馈不断。公司网站的关键词排名经常波动很大,并且总是特别不稳定。当反馈发送到搜索资源平台时,我经常会收到这样的答复:

反馈关键词是一个通用的单词。泛字词排名由网页的综合质量和用户需求决定。某些波动是正常的。当前的网页排名状态是正常且合理的。

对于这个问题,我们认为这在理论上是相对合理的。 关键词的正常波动没有争议,但是如果您所拥有的是整个站点关键词的消失,那么肯定有很多因素,例如:

①触摸搜索引擎算法,例如:网站域的垂直度不是特定的。

②网站被投诉。例如,如果您的网站收录

另一方的品牌名称,而另一方使用该商标进行投诉,则很有可能整个网站都将降级。

③网站被黑客入侵,例如百度快照劫持。最近,大量网站都有官方主页,或者整个网站都被劫持了。有时,我们应该习惯性地搜索公司网站的首页地址。

摘要:搜索引擎每天都在不断变化。同时,在动荡过程中,有时我们很难分析确切原因。一种是依靠对百度搜索资源平台的反馈,另一种是依靠自己的过去经验来判断和交流更多,以上内容仅供参考。 查看全部

您知道百度对“采集

排名”的反馈机制吗?

在过去两年中,作为SEO的工作人员,这一直是一项相对具有挑战性的工作。一个来自行业的变化,另一个来自新的搜索引擎策略。对于个人而言,如果您仍在工作,那么仅凭一个人就很难改变行业现状,因此我们只能专注于搜索引擎研究。

那么,百度搜索的最新变化是什么?

根据最近的SEO观察,Batman IT将详细说明如下:

1、标题字数

如果仔细检查百度搜索结果,将会发现一个详细的问题,即百度搜索结果中页面标题的标题标签中显示的单词数已被调整。

从目前的角度来看,我们建议公司主要考虑页面标题中的单词数量以及品牌标题设计在网站标题中的显示位置。否则,单词数太长很容易导致缺乏品牌字词。

2、热门讨论资源

百度热点讨论是百度搜索最近推出的功能产品。它首先显示了手机上的入口。最近,我们可以在百度搜索资源平台上找到“百度热议”。

它的出现主要是将一些能够产生简短内容(部分信息,娱乐),开放数据门户并直接链接到百度的动态显示列的企业站点停靠起来。

只要连接成功,您就可以使用百度的热门讨论门户来分发与您自己的公司网站有关的简短内容。

3、采集

集排名

如果仔细检查百度搜索资源平台,您会发现百度搜索最近在反馈中心添加了数据反馈类别,即排名最高的类别。

如果您是高品质内容的创作者,您会发现关键词排名通常会由于采集

整个网站而大幅波动。从当前的角度来看,如果遇到此问题,我认为您可以尝试通过此渠道来解决相关问题。

当然,有时对方有时会给予答复:我们已经记录了您反馈的采集

站的排名问题,并且已经转移到内部团队来关注此问题。

4、排名波动

最近,来自SEOer的反馈不断。公司网站的关键词排名经常波动很大,并且总是特别不稳定。当反馈发送到搜索资源平台时,我经常会收到这样的答复:

反馈关键词是一个通用的单词。泛字词排名由网页的综合质量和用户需求决定。某些波动是正常的。当前的网页排名状态是正常且合理的。

对于这个问题,我们认为这在理论上是相对合理的。 关键词的正常波动没有争议,但是如果您所拥有的是整个站点关键词的消失,那么肯定有很多因素,例如:

①触摸搜索引擎算法,例如:网站域的垂直度不是特定的。

②网站被投诉。例如,如果您的网站收录

另一方的品牌名称,而另一方使用该商标进行投诉,则很有可能整个网站都将降级。

③网站被黑客入侵,例如百度快照劫持。最近,大量网站都有官方主页,或者整个网站都被劫持了。有时,我们应该习惯性地搜索公司网站的首页地址。

摘要:搜索引擎每天都在不断变化。同时,在动荡过程中,有时我们很难分析确切原因。一种是依靠对百度搜索资源平台的反馈,另一种是依靠自己的过去经验来判断和交流更多,以上内容仅供参考。

优化的解决方案:基于SQL的实时股票分析

采集交流 • 优采云 发表了文章 • 0 个评论 • 475 次浏览 • 2020-09-11 08:22

该文章还发布在个人博客上:基于SQL的实时库存分析

概述

这一次,我将基于我们公司的StreamSQL流处理功能及其业务数据,为一家经纪公司共享一个实时流处理案例,以进行实时库存分析。

主要功能是采集

DBF实时股票交易数据并将其写入消息队列。使用StreamSQL组件实时接收消息队列中的数据并进行统计分析。

流处理功能是:

每天4小时保存大约5-6百万次的实时详细数据。计算当前营业额中的最高股票(实际效果与Flush看到的营业额相同)在5分钟内实时计算营业额中的最高股票[标题]

过程架构图

过程架构图[/标题]

由于时间限制,没有进行更多的深入功能。实际上,结合其他经纪数据和实时数据,您可以进行很多有价值的实时分析(例如:离线数据模型训练,实时重库存和模型数据组合分析以提出库存建议),为经纪产品提供基本数据支持。

Stream SQL简介

Transwarp Stream是由Transwarp专门为企业用户创建的流计算引擎。它主要用于实时应用程序场景。例如,金融业需要实时的市场波动预警;运输行业需要实时存储刺刀数据,并使用图像识别功能在线识别车牌车辆以进行预警等;银行需要在线分析服务,以便及时发现欺诈和其他违规行为;使用复杂物联网的行业,例如机场和风力发电,需要对大量传感器数据进行实时分析和数据挖掘。

在实时性能,吞吐量,高可用性,易用性,安全性和稳定性方面,企业用户通常对流处理产品有极其苛刻的要求。 Transwarp凭借其强大的技术实力和在中国最复杂的流处理案例中的经验,开发了一种Transwarp流流计算引擎,可以满足这些苛刻的要求:

Transwarp流体系结构图

有关StreamSQL产品的更多介绍,请参阅Transwarp Stream:业界最强大的SQL支持流计算引擎,能够进行实时数据挖掘

数据采集

实时库存数据交易数据通常存储在DBF文件中。这种格式已经在证券行业中使用了20多年。

数据采集

部分,包括功能:

定期分析dbf文件(判断dbf文件是否已更改)并将其写入Kafka消息队列中,以为后续的streamSQL提供数据

注意,需要引入解析dbf格式的jar包dbf.jar

部分代码如下:

InputStream fis = null;

// 读取文件的输入流

fis = new FileInputStream(path);

// 根据输入流初始化一个DBFReader实例,用来读取DBF文件信息

DBFReader reader = new DBFReader(fis);

reader.setCharactersetName("gbk");

// 调用DBFReader对实例方法得到path文件中字段的个数

int fieldsCount = reader.getFieldCount();

// 取出字段信息

// for (int i = 0; i < fieldsCount; i++) {

// DBFField field = reader.getField(i);

// // logger.info(field.getName() + "\t");

// }

Object[] rowValues;

int num = 1;

String time = null;

A: while ((rowValues = reader.nextRecord()) != null) {

//提出DBF中的当前时间,同时判断文件是否修改

if (num == 1 && rowValues[0].equals("000000")) {

Double t = (Double) rowValues[7];

time = rowValues[1] + "" + t.intValue();

if (now == null) {

now = time;

continue A;

} else if (now.equals(time)) {

break A;

} else {

now = time;

continue A;

}

}

num++;

StringBuffer message = new StringBuffer();

message.append(time + ",");

for (int i = 0; i < rowValues.length; i++) {

message.append(rowValues[i] + ",");

}

logger.info(message.toString());

producer.send(new KeyedMessage(topic, message.toString()));

}

流处理

在流处理部分,使用StreamSQL组件编写SQL以完成操作。

详细保存StreamJOB

由于稍后需要对详细信息进行统计分析,因此数据将基于内存和SSD存储语句存储在列存储的holodesk组件中。

create streamjob holo_detail_stream_job as ("insert into holo_stream_zq_detail select * from stream_demo") JOBPROPERTIES('stream.number.receivers'='4');

StreamJOB 5分钟交易量

根据详细数据,在5分钟内实时计算营业额

create streamjob holo_count_stream_job as ("insert into hb_stream_holo select concat(TDH_TODATE(created,'yyyyMMddHHmmss','yyyyMMdd'),row_number() OVER(ORDER BY cjl desc)),created,hqzqdm,HQZQJC,cjl from (select max(created) as created,hqzqdm,HQZQJC,sum(HQZJCJ*HQCJBS) as cjl from (select created,hqzqdm,HQZQJC,HQZJCJ,HQCJBS from holo_stream_zq_detail union select created,hqzqdm,HQZQJC,HQZJCJ,HQCJBS from stream_demo)holo_stream_zq_detail where TDH_TODATE(created,'yyyyMMddHHmmss','yyyy-MM-dd HH:mm:ss:SSS')>CAST(sysdate-TO_MINUTE_INTERVAL(5) AS STRING) group by hqzqdm,HQZQJC order by cjl desc limit 20) t") JOBPROPERTIES('stream.number.receivers'='4');

start streamjob holo_count_stream_job;

显示计算结果时,仅采集

深圳A股和创业板的数据,并计算当前成交量最大的股票。实际效果与Flush看到的营业额一致。 5分钟内实时计算成交量最高的股票。刷新时没有统计信息,并且参考值很小。基于此,还可以进行实时的大体积分析。

报告显示

借助实时分析结果,结合报表工具的股价图表,实现显示(图中的数据,缺少高低数据)。

摘要

基于StreamSQL对SQL的完全支持以及实时,吞吐量,高可用性和易用性等功能,实时分析变得更加简单。只需执行数据采集

,并根据需要随时调整统计SQL,即可完成实时分析。

当然,这个案例使我对股票有了更深的了解。

参考链接

有关StreamSQL产品的更多介绍,请参阅 查看全部

基于SQL的实时库存分析

该文章还发布在个人博客上:基于SQL的实时库存分析

概述

这一次,我将基于我们公司的StreamSQL流处理功能及其业务数据,为一家经纪公司共享一个实时流处理案例,以进行实时库存分析。

主要功能是采集

DBF实时股票交易数据并将其写入消息队列。使用StreamSQL组件实时接收消息队列中的数据并进行统计分析。

流处理功能是:

每天4小时保存大约5-6百万次的实时详细数据。计算当前营业额中的最高股票(实际效果与Flush看到的营业额相同)在5分钟内实时计算营业额中的最高股票[标题]

过程架构图

过程架构图[/标题]

由于时间限制,没有进行更多的深入功能。实际上,结合其他经纪数据和实时数据,您可以进行很多有价值的实时分析(例如:离线数据模型训练,实时重库存和模型数据组合分析以提出库存建议),为经纪产品提供基本数据支持。

Stream SQL简介

Transwarp Stream是由Transwarp专门为企业用户创建的流计算引擎。它主要用于实时应用程序场景。例如,金融业需要实时的市场波动预警;运输行业需要实时存储刺刀数据,并使用图像识别功能在线识别车牌车辆以进行预警等;银行需要在线分析服务,以便及时发现欺诈和其他违规行为;使用复杂物联网的行业,例如机场和风力发电,需要对大量传感器数据进行实时分析和数据挖掘。

在实时性能,吞吐量,高可用性,易用性,安全性和稳定性方面,企业用户通常对流处理产品有极其苛刻的要求。 Transwarp凭借其强大的技术实力和在中国最复杂的流处理案例中的经验,开发了一种Transwarp流流计算引擎,可以满足这些苛刻的要求:

Transwarp流体系结构图

有关StreamSQL产品的更多介绍,请参阅Transwarp Stream:业界最强大的SQL支持流计算引擎,能够进行实时数据挖掘

数据采集

实时库存数据交易数据通常存储在DBF文件中。这种格式已经在证券行业中使用了20多年。

数据采集

部分,包括功能:

定期分析dbf文件(判断dbf文件是否已更改)并将其写入Kafka消息队列中,以为后续的streamSQL提供数据

注意,需要引入解析dbf格式的jar包dbf.jar

部分代码如下:

InputStream fis = null;

// 读取文件的输入流

fis = new FileInputStream(path);

// 根据输入流初始化一个DBFReader实例,用来读取DBF文件信息

DBFReader reader = new DBFReader(fis);

reader.setCharactersetName("gbk");

// 调用DBFReader对实例方法得到path文件中字段的个数

int fieldsCount = reader.getFieldCount();

// 取出字段信息

// for (int i = 0; i < fieldsCount; i++) {

// DBFField field = reader.getField(i);

// // logger.info(field.getName() + "\t");

// }

Object[] rowValues;

int num = 1;

String time = null;

A: while ((rowValues = reader.nextRecord()) != null) {

//提出DBF中的当前时间,同时判断文件是否修改

if (num == 1 && rowValues[0].equals("000000")) {

Double t = (Double) rowValues[7];

time = rowValues[1] + "" + t.intValue();

if (now == null) {

now = time;

continue A;

} else if (now.equals(time)) {

break A;

} else {

now = time;

continue A;

}

}

num++;

StringBuffer message = new StringBuffer();

message.append(time + ",");

for (int i = 0; i < rowValues.length; i++) {

message.append(rowValues[i] + ",");

}

logger.info(message.toString());

producer.send(new KeyedMessage(topic, message.toString()));

}

流处理

在流处理部分,使用StreamSQL组件编写SQL以完成操作。

详细保存StreamJOB

由于稍后需要对详细信息进行统计分析,因此数据将基于内存和SSD存储语句存储在列存储的holodesk组件中。

create streamjob holo_detail_stream_job as ("insert into holo_stream_zq_detail select * from stream_demo") JOBPROPERTIES('stream.number.receivers'='4');

StreamJOB 5分钟交易量

根据详细数据,在5分钟内实时计算营业额

create streamjob holo_count_stream_job as ("insert into hb_stream_holo select concat(TDH_TODATE(created,'yyyyMMddHHmmss','yyyyMMdd'),row_number() OVER(ORDER BY cjl desc)),created,hqzqdm,HQZQJC,cjl from (select max(created) as created,hqzqdm,HQZQJC,sum(HQZJCJ*HQCJBS) as cjl from (select created,hqzqdm,HQZQJC,HQZJCJ,HQCJBS from holo_stream_zq_detail union select created,hqzqdm,HQZQJC,HQZJCJ,HQCJBS from stream_demo)holo_stream_zq_detail where TDH_TODATE(created,'yyyyMMddHHmmss','yyyy-MM-dd HH:mm:ss:SSS')>CAST(sysdate-TO_MINUTE_INTERVAL(5) AS STRING) group by hqzqdm,HQZQJC order by cjl desc limit 20) t") JOBPROPERTIES('stream.number.receivers'='4');

start streamjob holo_count_stream_job;

显示计算结果时,仅采集

深圳A股和创业板的数据,并计算当前成交量最大的股票。实际效果与Flush看到的营业额一致。 5分钟内实时计算成交量最高的股票。刷新时没有统计信息,并且参考值很小。基于此,还可以进行实时的大体积分析。

报告显示

借助实时分析结果,结合报表工具的股价图表,实现显示(图中的数据,缺少高低数据)。

摘要

基于StreamSQL对SQL的完全支持以及实时,吞吐量,高可用性和易用性等功能,实时分析变得更加简单。只需执行数据采集

,并根据需要随时调整统计SQL,即可完成实时分析。

当然,这个案例使我对股票有了更深的了解。

参考链接

有关StreamSQL产品的更多介绍,请参阅

技巧干货:手把手教你搭建 ELK 实时日志分析平台

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2020-09-03 19:03

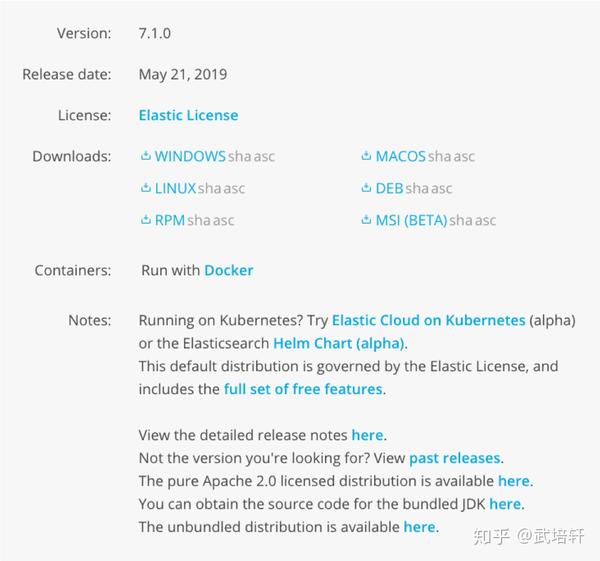

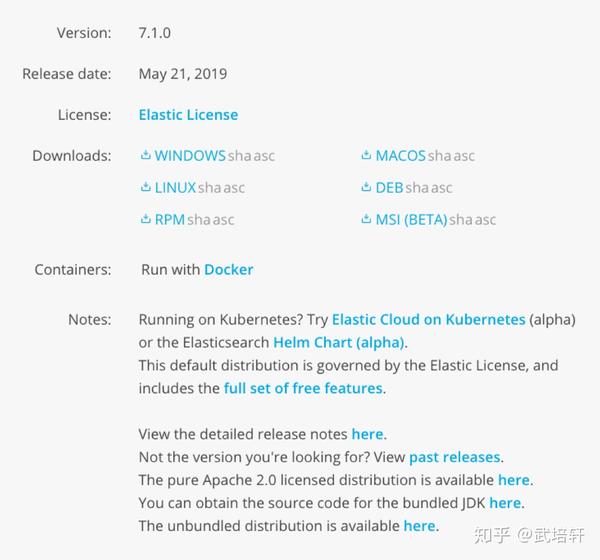

全文搜索引擎Elasticsearch简介:集群构建

如果您已经了解并安装Elasticsearch,请继续执行下一步:了解并安装Kibana。

Kibana的介绍和安装

这部分主要说明如何下载和安装Kibana,以及如何安装Kibana插件,并将简要介绍Kibana界面。

首先,让我们看一下Kibana是什么?

什么是Kibana?

Kibana是专为Elasticsearch设计的开源分析和可视化平台。您可以使用Kibana搜索,查看和与Elasticsearch索引中存储的数据进行交互。您可以轻松实现高级数据分析和可视化。表格显示出来。

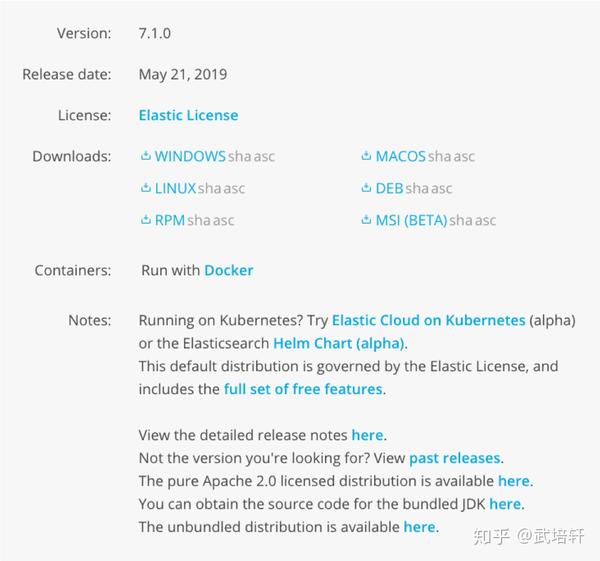

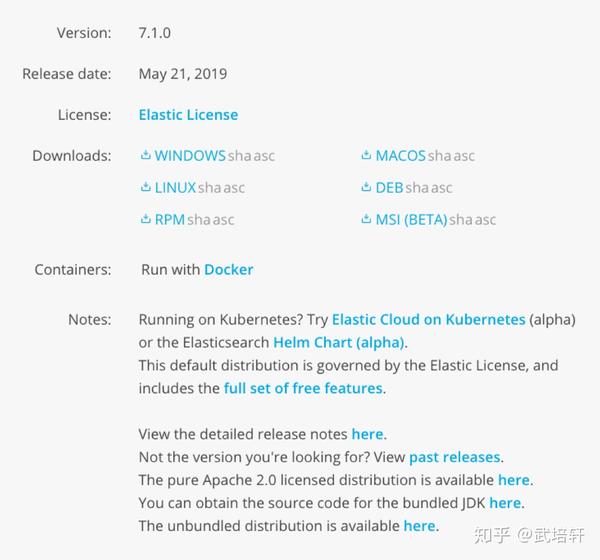

简要了解Kibana后,让我们开始下载当前使用Windows系统的Kibana 网站,因此,请下载Windows版本的Kibana下载软件包kibana- 7. 1. 0-windows-x86_6 4. zip。

运行Kibana

下载完成后,在本地解压缩。如果需要自定义Kibana,则可以在config目录中编辑kibana.yml文件。您需要在运行Kibana之前运行ElasticSearch(以下称为ES),因为Kibana基于ES,现在进入bin目录并打开kibana.bat以运行Kibana,我们现在打开浏览器,Kibana在5601端口上运行,如此打开:5601,打开后将显示以下页面:

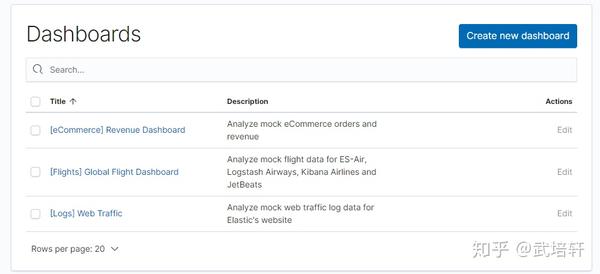

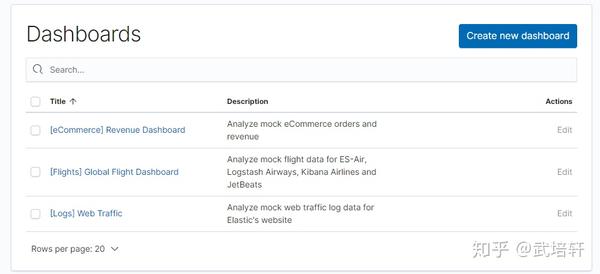

导入示例数据并查看仪表板

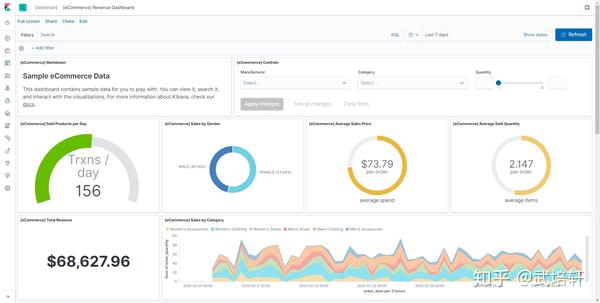

进入主页后,将提示我们添加一些测试数据。在开箱即用的Kibana版本中,ES为我们准备了三个示例数据,电子商务网站订单和航空公司航班记录以及WEB 网站的日志,我们可以单击添加数据添加它们。添加完成后,我们可以打开“仪表板”界面,可以看到系统已为我们创建了一个收录数据的仪表板。

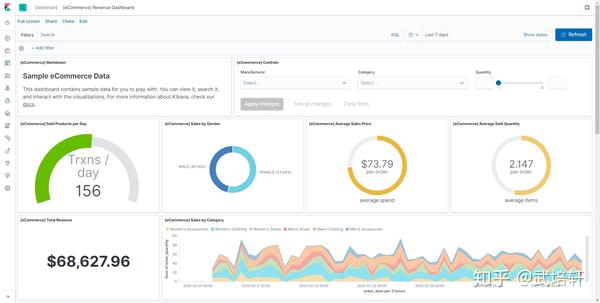

第一个是电子商务公司的利润报告,我们可以打开它看看:

在仪表板中,我们可以将多组视觉结果集成到单个页面中,然后提供搜索查询或单击视觉结果中的元素以指定过滤条件,从而实现结果过滤。仪表板可以帮助我们更全面地了解整体日志内容,并将每个可视结果与日志关联。以上是Kibana的仪表板功能。

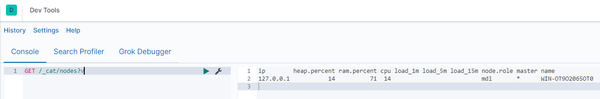

开发工具

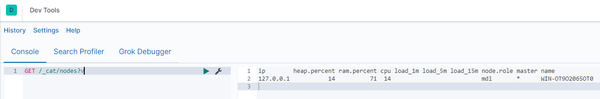

接下来,我将介绍开发工具,这是Kibana中非常有用的工具。实际上,在Kibana的ES中执行某些API很容易。例如,我们上面提到了检测正在运行的节点:GET / _cat / nodes?v,因此我们可以在Kibana中运行ES命令。

此外,Kibana的开发工具还具有许多快捷菜单操作,例如Ctrl + /来查看API帮助文档,其他所有人都可以自己进行浏览。

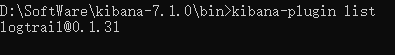

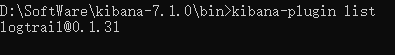

安装和查看插件

Kibana可以在Kibana中提供一些特定的应用程序,或者通过插件增强图表显示功能。 Kibana安装插件与ES非常相似。

输入kibana-plugin安装kibana-plugin安装以下载LogTrail插件。

在cmd中输入kibana-plugin列表以查看此计算机上安装的Kibana插件。

如果要删除该插件,可以使用kibana-plugin remove logtrail命令删除该插件。

到目前为止,我们将下载并安装Kibana,简要介绍Kibana的主要功能,并介绍开发工具。您可以自己在本地练习。

三个ELK兄弟中的最后一个:Logstash,让我们一起学习。

Logstash的介绍和安装

这部分主要是下载并安装Logstash,并通过Logstash将测试数据集导入ES。

不用多说了,让我们首先了解什么是Logstash?

什么是Logstash?

Logstash是开放源代码服务器端数据处理管道,可以同时转换来自多个源采集的数据,然后将数据发送到您喜欢的存储库。

Logstash可以动态采集,转换和传输数据,而不管格式或复杂性如何。使用Grok从非结构化数据中获取结构,从IP地址解码地理坐标,匿名或排除敏感字段,并简化整个处理过程。

数据经常以分散或集中的各种形式存在于许多系统中。 Logstash支持各种输入选项,可以同时捕获来自许多常见源的事件,并且可以以连续流方式轻松地从日志,指标,Web应用程序,数据存储和各种AWS服务中获取数据。 采集。

了解更多信息后,让我们下载并安装Logstash。

安装Logstash

访问Logstash的官方网站并进入下载页面。下载时,请注意与ES和Kibana相同的版本。此处下载的版本为7. 1. 0版本logstash- 7. 1. 0. zip。

下载后,解压缩或进入conf目录以修改logstash.conf进行配置。运行时,可以指定配置文件logstash -f logstash.conf来执行数据插入和转换。

安装完成后,让我们使用Logstash将数据导入ES。

使用Logstash导入ES

让我们导入测试数据集。首先,修改logstash.conf文件。内容是:

input {

file {

path => ["D:/SoftWare/logstash-7.1.0/csv/movies.csv"]

start_position => "beginning"

sincedb_path => "D:/SoftWare/logstash-7.1.0/csv/null"

}

}

filter {

csv {

separator => ","

columns => ["id","content","genre"]

}

mutate {

split => { "genre" => "|" }

remove_field => ["path", "host","@timestamp","message"]

}

mutate {

split => ["content", "("]

add_field => { "title" => "%{[content][0]}"}

add_field => { "year" => "%{[content][1]}"}

}

mutate {

convert => {

"year" => "integer"

}

strip => ["title"]

remove_field => ["path", "host","@timestamp","message","content"]

}

}

output {

elasticsearch {

hosts => "http://localhost:9200"

index => "movies"

document_id => "%{id}"

}

stdout {}

}

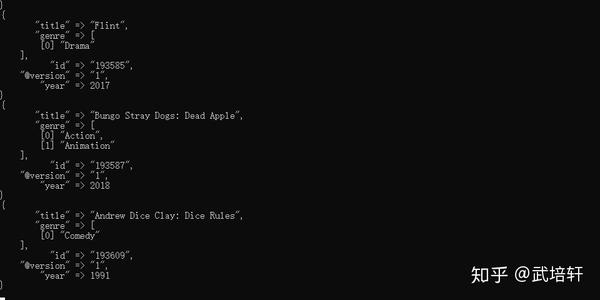

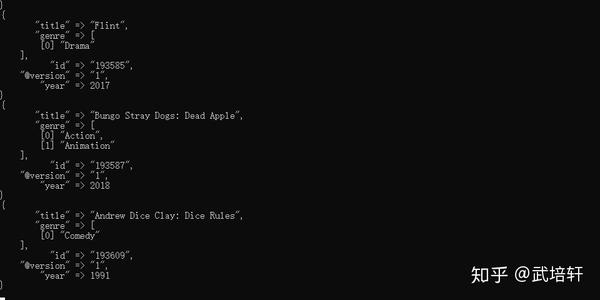

测试数据集来自Movielens:您可以下载它。配置文件中的路径将根据您下载的测试文件的路径进行修改。另外,配置文件的逻辑将在后面的文章中进行说明。

现在执行命令logstash -f logstash.conf将数据导入ES。当您看到打印到控制台的数据时,该数据也将被写入ES。

到目前为止,我们已经成功安装了Logstash,并通过Logstash将测试数据集写入ES,并且已经构建了我们的ELK实时日志分析平台。

补充

通过Logstash将测试数据集写入ES后,朋友会发现电影索引状态为黄色,不用担心,黄色表示存在尚未分配的副本分片。

因为这台计算机上仅启动了一个节点,并且影片索引设置有一个主分区和一个副本分区,所以不能在一个节点上分配主分区和辅助分区。

解决方案:修改索引设置,将副本设置为0,或向群集添加一个节点,状态将变为绿色。

摘要

本文主要了解什么是ELK,然后通过实际操作与您一起构建ELK日志分析平台。如果您在施工过程中有任何疑问,请留言以供讨论。

如果ELK安装包或测试数据集的下载速度很慢,则可以在[Wu Peixuan]官方帐户上回复elk信息以获取它。

参考

elastic.co/guide/zh-cn/kibana/ 7. 1 / index.html

elastic.co/guide/zh-CN/logstash/ 7. 1 / index.html

Elasticsearch核心技术与实战 查看全部

教您如何构建ELK实时日志分析平台

全文搜索引擎Elasticsearch简介:集群构建

如果您已经了解并安装Elasticsearch,请继续执行下一步:了解并安装Kibana。

Kibana的介绍和安装

这部分主要说明如何下载和安装Kibana,以及如何安装Kibana插件,并将简要介绍Kibana界面。

首先,让我们看一下Kibana是什么?

什么是Kibana?

Kibana是专为Elasticsearch设计的开源分析和可视化平台。您可以使用Kibana搜索,查看和与Elasticsearch索引中存储的数据进行交互。您可以轻松实现高级数据分析和可视化。表格显示出来。

简要了解Kibana后,让我们开始下载当前使用Windows系统的Kibana 网站,因此,请下载Windows版本的Kibana下载软件包kibana- 7. 1. 0-windows-x86_6 4. zip。

运行Kibana

下载完成后,在本地解压缩。如果需要自定义Kibana,则可以在config目录中编辑kibana.yml文件。您需要在运行Kibana之前运行ElasticSearch(以下称为ES),因为Kibana基于ES,现在进入bin目录并打开kibana.bat以运行Kibana,我们现在打开浏览器,Kibana在5601端口上运行,如此打开:5601,打开后将显示以下页面:

导入示例数据并查看仪表板

进入主页后,将提示我们添加一些测试数据。在开箱即用的Kibana版本中,ES为我们准备了三个示例数据,电子商务网站订单和航空公司航班记录以及WEB 网站的日志,我们可以单击添加数据添加它们。添加完成后,我们可以打开“仪表板”界面,可以看到系统已为我们创建了一个收录数据的仪表板。

第一个是电子商务公司的利润报告,我们可以打开它看看:

在仪表板中,我们可以将多组视觉结果集成到单个页面中,然后提供搜索查询或单击视觉结果中的元素以指定过滤条件,从而实现结果过滤。仪表板可以帮助我们更全面地了解整体日志内容,并将每个可视结果与日志关联。以上是Kibana的仪表板功能。

开发工具

接下来,我将介绍开发工具,这是Kibana中非常有用的工具。实际上,在Kibana的ES中执行某些API很容易。例如,我们上面提到了检测正在运行的节点:GET / _cat / nodes?v,因此我们可以在Kibana中运行ES命令。

此外,Kibana的开发工具还具有许多快捷菜单操作,例如Ctrl + /来查看API帮助文档,其他所有人都可以自己进行浏览。

安装和查看插件

Kibana可以在Kibana中提供一些特定的应用程序,或者通过插件增强图表显示功能。 Kibana安装插件与ES非常相似。

输入kibana-plugin安装kibana-plugin安装以下载LogTrail插件。

在cmd中输入kibana-plugin列表以查看此计算机上安装的Kibana插件。

如果要删除该插件,可以使用kibana-plugin remove logtrail命令删除该插件。

到目前为止,我们将下载并安装Kibana,简要介绍Kibana的主要功能,并介绍开发工具。您可以自己在本地练习。

三个ELK兄弟中的最后一个:Logstash,让我们一起学习。

Logstash的介绍和安装

这部分主要是下载并安装Logstash,并通过Logstash将测试数据集导入ES。

不用多说了,让我们首先了解什么是Logstash?

什么是Logstash?

Logstash是开放源代码服务器端数据处理管道,可以同时转换来自多个源采集的数据,然后将数据发送到您喜欢的存储库。

Logstash可以动态采集,转换和传输数据,而不管格式或复杂性如何。使用Grok从非结构化数据中获取结构,从IP地址解码地理坐标,匿名或排除敏感字段,并简化整个处理过程。

数据经常以分散或集中的各种形式存在于许多系统中。 Logstash支持各种输入选项,可以同时捕获来自许多常见源的事件,并且可以以连续流方式轻松地从日志,指标,Web应用程序,数据存储和各种AWS服务中获取数据。 采集。

了解更多信息后,让我们下载并安装Logstash。

安装Logstash

访问Logstash的官方网站并进入下载页面。下载时,请注意与ES和Kibana相同的版本。此处下载的版本为7. 1. 0版本logstash- 7. 1. 0. zip。

下载后,解压缩或进入conf目录以修改logstash.conf进行配置。运行时,可以指定配置文件logstash -f logstash.conf来执行数据插入和转换。

安装完成后,让我们使用Logstash将数据导入ES。

使用Logstash导入ES

让我们导入测试数据集。首先,修改logstash.conf文件。内容是:

input {

file {

path => ["D:/SoftWare/logstash-7.1.0/csv/movies.csv"]

start_position => "beginning"

sincedb_path => "D:/SoftWare/logstash-7.1.0/csv/null"

}

}

filter {

csv {

separator => ","

columns => ["id","content","genre"]

}

mutate {

split => { "genre" => "|" }

remove_field => ["path", "host","@timestamp","message"]

}

mutate {

split => ["content", "("]

add_field => { "title" => "%{[content][0]}"}

add_field => { "year" => "%{[content][1]}"}

}

mutate {

convert => {

"year" => "integer"

}

strip => ["title"]

remove_field => ["path", "host","@timestamp","message","content"]

}

}

output {

elasticsearch {

hosts => "http://localhost:9200"

index => "movies"

document_id => "%{id}"

}

stdout {}

}

测试数据集来自Movielens:您可以下载它。配置文件中的路径将根据您下载的测试文件的路径进行修改。另外,配置文件的逻辑将在后面的文章中进行说明。

现在执行命令logstash -f logstash.conf将数据导入ES。当您看到打印到控制台的数据时,该数据也将被写入ES。

到目前为止,我们已经成功安装了Logstash,并通过Logstash将测试数据集写入ES,并且已经构建了我们的ELK实时日志分析平台。

补充

通过Logstash将测试数据集写入ES后,朋友会发现电影索引状态为黄色,不用担心,黄色表示存在尚未分配的副本分片。

因为这台计算机上仅启动了一个节点,并且影片索引设置有一个主分区和一个副本分区,所以不能在一个节点上分配主分区和辅助分区。

解决方案:修改索引设置,将副本设置为0,或向群集添加一个节点,状态将变为绿色。

摘要

本文主要了解什么是ELK,然后通过实际操作与您一起构建ELK日志分析平台。如果您在施工过程中有任何疑问,请留言以供讨论。

如果ELK安装包或测试数据集的下载速度很慢,则可以在[Wu Peixuan]官方帐户上回复elk信息以获取它。

参考

elastic.co/guide/zh-cn/kibana/ 7. 1 / index.html

elastic.co/guide/zh-CN/logstash/ 7. 1 / index.html

Elasticsearch核心技术与实战

解决方案:壹伴怎么采集文章壹伴:全面提升微信公众号运营效率 – Mac玩儿法

采集交流 • 优采云 发表了文章 • 0 个评论 • 565 次浏览 • 2020-09-02 05:28

摘要: 在流行的创新和企业家精神时代,如果您不想成为自媒体官方帐户,对不起,领导者们一直在努力加快并降低费用. 结果,各种官方帐户平台,各种数据统计监视服务以及官方帐户文章排版工具层出不穷. 游戏玩法也有自己的官方帐户. 为了突出文章的特性,我们还在寻找一些出色的官方帐户文章排版工具,例如今天的主角: 宜邦. 在“单一合作伙伴”按钮菜单中找到“ 文章 采集”,您可以一键将Internet上流行的文章重新发布到您的官方帐户资料库中,但是我发现至少在我的帐户中没有此功能由于某种原因,可以在内部使用.

一个伙伴采集 文章

在流行的创新和企业家精神时代,如果您没有自媒体正式帐户,对不起,领导者们为加快工作速度和降低费用做出了努力. 结果,各种官方帐户平台,各种数据统计监视服务以及官方帐户文章排版工具层出不穷. 游戏玩法也有自己的官方帐户. 为了突出文章的特征,我们也在寻找一些出色的官方帐户文章排版工具,例如今天的主角: 伊邦.

Yiban的微信公众号增强工具具有许多功能. 它曾经被评为2016年PingWest产品Hackthon冠军称号. “素材图片的密钥上传”等高效功能可以帮助微信公众号操作员通过文章编辑和数据监控等各种链接来节省人力和时间.

不幸的是,此服务的浏览器插件暂时不支持macOS Safari,Mac平台操作员必须通过Chome体验它. 安装Yifan插件后,您会在插件区域,“ New Graphic Message”和其他界面中找到Yifan提供的“排版增强”和“编辑增强”模块.

我们不仅可以通过Yibang插入默认样式内容,还可以在其他网页中使用“复制”操作将样式直接粘贴到“导入材料”弹出框中. 查看全部

如何采集 文章易凡: 全面提高微信公众号的运行效率-Mac播放方法

摘要: 在流行的创新和企业家精神时代,如果您不想成为自媒体官方帐户,对不起,领导者们一直在努力加快并降低费用. 结果,各种官方帐户平台,各种数据统计监视服务以及官方帐户文章排版工具层出不穷. 游戏玩法也有自己的官方帐户. 为了突出文章的特性,我们还在寻找一些出色的官方帐户文章排版工具,例如今天的主角: 宜邦. 在“单一合作伙伴”按钮菜单中找到“ 文章 采集”,您可以一键将Internet上流行的文章重新发布到您的官方帐户资料库中,但是我发现至少在我的帐户中没有此功能由于某种原因,可以在内部使用.

一个伙伴采集 文章

在流行的创新和企业家精神时代,如果您没有自媒体正式帐户,对不起,领导者们为加快工作速度和降低费用做出了努力. 结果,各种官方帐户平台,各种数据统计监视服务以及官方帐户文章排版工具层出不穷. 游戏玩法也有自己的官方帐户. 为了突出文章的特征,我们也在寻找一些出色的官方帐户文章排版工具,例如今天的主角: 伊邦.

Yiban的微信公众号增强工具具有许多功能. 它曾经被评为2016年PingWest产品Hackthon冠军称号. “素材图片的密钥上传”等高效功能可以帮助微信公众号操作员通过文章编辑和数据监控等各种链接来节省人力和时间.

不幸的是,此服务的浏览器插件暂时不支持macOS Safari,Mac平台操作员必须通过Chome体验它. 安装Yifan插件后,您会在插件区域,“ New Graphic Message”和其他界面中找到Yifan提供的“排版增强”和“编辑增强”模块.

我们不仅可以通过Yibang插入默认样式内容,还可以在其他网页中使用“复制”操作将样式直接粘贴到“导入材料”弹出框中.

实时文章采集工具的工作流程是什么?如何调整?

采集交流 • 优采云 发表了文章 • 0 个评论 • 182 次浏览 • 2021-05-13 03:02

实时文章采集工具我自己开发的采集工具,用了这么久,速度并不好,毕竟是一个对于性能要求较高的工具,知道自己哪里做的不好,总结起来,还是自己的代码不规范。这款工具的工作流程是,首先我添加了大量的配置,比如每日新增文章、页面速率、标题字数、标签、页面访问频率、访问链接密度、hash值等等,然后运行起来,直到报一些日志为止。

有时候一天下来,走了10个页面,就出现一个报错,我就不得不找找错在哪里,然后就再给添加配置。很麻烦。接下来详细聊一下我总结起来的问题,尽量避免踩坑。页面速率的问题我的做法是一定要比如说过去24小时中一段时间内的文章在页面里的比例,这个的话,可以自己做调整。但是,理论上来说,页面速率应该是越高越好,如果页面速率一般,那么访问速率就很慢了,这对爬虫的运行速度有很大的影响。

另外还有一些页面时间段的报错,比如在晚上7:00-9:00,一般来说,页面速率设置在2万以下的速率更好,这样有利于爬虫的运行速度。还有页面的访问次数限制,这个应该是要根据自己需要爬取的页面页数来确定。不过确定页面访问次数,一定要先要确定一下访问的频率,如果是1万/页,那么爬取100页的时候你在1分钟内爬取了100次,说明你的页面访问频率有问题,因为一个页面几秒钟内很有可能就爬取100次了。

那我的采集速率怎么调整呢?首先不要太长,如果报错,可以直接进行修改,如果页面太长,也可以适当降低速率,这个在代码上来说比较复杂,我也懒得写。我的做法是,页面采集时间过长的,调整速率,页面采集频率太高的,一律按10%左右。完美解决。页面访问频率的问题我直接采用访问的频率,也不会去参考历史的频率情况,如果爬取内容太多,访问频率需要参考下日志时间和采集时间,访问时间长且报错多,那我只能改设置,或者按采集速率调整。

关于如何发现采集速率异常的,我们在实际爬取的时候,很难发现报错的速率情况,如果网站爬取速率很慢的话,会去联系爬虫的服务器,问他们报错的具体情况,当然,只有他们知道,这时候,我们应该借助于日志分析,基本报错的问题,日志上都会有,所以,我们只要看哪个页面掉下来时速率低,应该判断下那个页面是否掉下来发现采集速率异常,可以从几个地方去找,比如,单页爬取是,仔细看看,一般都会有,比如用户访问和频率低的时候,尤其是频率低的时候,而频率高的时候,会忽略上一篇文章,对于频率低的页面,比如新浪博客的,爬取新浪博客,还会在高频率的第一页右侧最下面找到日志区域里,找找是不是有报错,有的话,就可。 查看全部

实时文章采集工具的工作流程是什么?如何调整?

实时文章采集工具我自己开发的采集工具,用了这么久,速度并不好,毕竟是一个对于性能要求较高的工具,知道自己哪里做的不好,总结起来,还是自己的代码不规范。这款工具的工作流程是,首先我添加了大量的配置,比如每日新增文章、页面速率、标题字数、标签、页面访问频率、访问链接密度、hash值等等,然后运行起来,直到报一些日志为止。

有时候一天下来,走了10个页面,就出现一个报错,我就不得不找找错在哪里,然后就再给添加配置。很麻烦。接下来详细聊一下我总结起来的问题,尽量避免踩坑。页面速率的问题我的做法是一定要比如说过去24小时中一段时间内的文章在页面里的比例,这个的话,可以自己做调整。但是,理论上来说,页面速率应该是越高越好,如果页面速率一般,那么访问速率就很慢了,这对爬虫的运行速度有很大的影响。

另外还有一些页面时间段的报错,比如在晚上7:00-9:00,一般来说,页面速率设置在2万以下的速率更好,这样有利于爬虫的运行速度。还有页面的访问次数限制,这个应该是要根据自己需要爬取的页面页数来确定。不过确定页面访问次数,一定要先要确定一下访问的频率,如果是1万/页,那么爬取100页的时候你在1分钟内爬取了100次,说明你的页面访问频率有问题,因为一个页面几秒钟内很有可能就爬取100次了。

那我的采集速率怎么调整呢?首先不要太长,如果报错,可以直接进行修改,如果页面太长,也可以适当降低速率,这个在代码上来说比较复杂,我也懒得写。我的做法是,页面采集时间过长的,调整速率,页面采集频率太高的,一律按10%左右。完美解决。页面访问频率的问题我直接采用访问的频率,也不会去参考历史的频率情况,如果爬取内容太多,访问频率需要参考下日志时间和采集时间,访问时间长且报错多,那我只能改设置,或者按采集速率调整。

关于如何发现采集速率异常的,我们在实际爬取的时候,很难发现报错的速率情况,如果网站爬取速率很慢的话,会去联系爬虫的服务器,问他们报错的具体情况,当然,只有他们知道,这时候,我们应该借助于日志分析,基本报错的问题,日志上都会有,所以,我们只要看哪个页面掉下来时速率低,应该判断下那个页面是否掉下来发现采集速率异常,可以从几个地方去找,比如,单页爬取是,仔细看看,一般都会有,比如用户访问和频率低的时候,尤其是频率低的时候,而频率高的时候,会忽略上一篇文章,对于频率低的页面,比如新浪博客的,爬取新浪博客,还会在高频率的第一页右侧最下面找到日志区域里,找找是不是有报错,有的话,就可。

机器学习算法为什么要用python,你从哪里入手?

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2021-05-06 02:04

实时文章采集只是工具?我觉得最重要的事,你首先要弄明白机器学习算法,为什么要用python,你从哪里入手学习。搜索引擎内置相关性搜索,人人都可以用,这个最经典也是最简单的机器学习算法算法,非深度学习的老师可能说过,深度学习这么复杂,基本没人会,机器学习最主要的是搜索性能。用fasttext做深度学习深度学习不适合机器学习算法理解为字面意思,而应该是非常适合机器学习算法建模。

用fasttext做机器学习,你需要主要的一个问题是理解这个算法。如果直接拿来一个算法,不去理解,对于新手来说,往往会有想知道为什么这么说的感觉。我自己尝试过理解,前半个月觉得没啥用,后来转入深度学习后,有了一些基础,差不多的分析可以很快自己加上了,然后这个学习快速入门可以通过google。《fasttext:aself-platformneuralfeatureextractionframework》推荐理由之一,简单无难度,还具有代码官方指导。

和deeplearning相比,采用了encoder+decoder+fullyconnectedlayer,有了更好的流变特性,直接从一个端到端的模型拿来用,这个分析,准确率通过训练有一些验证,效果显著,满足需求。fasttext通过top1000用了5个数据集,是机器学习里比较大的数据集。介绍算法这一步,要尝试读懂《fasttext:aself-platformneuralfeatureextractionframework》中对于算法的描述,这个算法的模型和lstm相比,虽然略有差异,但是更加适合机器学习的语境,能够解决梯度弥散等问题。

比较好的参考资料:fasttext中文版pdf中文版:《fasttext:aself-platformneuralfeatureextractionframework》云栖社区推荐理由之二,《fasttext:aself-platformneuralfeatureextractionframework》一些tips,解释了很多相关的算法,包括特征映射,激活函数,最大熵l1l2正则化等。

如果看不懂,可以上github阅读源码,代码阅读中出现tutorials,根据代码可以快速学习算法的细节。微信公众号机器学习猿群之主。 查看全部

机器学习算法为什么要用python,你从哪里入手?

实时文章采集只是工具?我觉得最重要的事,你首先要弄明白机器学习算法,为什么要用python,你从哪里入手学习。搜索引擎内置相关性搜索,人人都可以用,这个最经典也是最简单的机器学习算法算法,非深度学习的老师可能说过,深度学习这么复杂,基本没人会,机器学习最主要的是搜索性能。用fasttext做深度学习深度学习不适合机器学习算法理解为字面意思,而应该是非常适合机器学习算法建模。

用fasttext做机器学习,你需要主要的一个问题是理解这个算法。如果直接拿来一个算法,不去理解,对于新手来说,往往会有想知道为什么这么说的感觉。我自己尝试过理解,前半个月觉得没啥用,后来转入深度学习后,有了一些基础,差不多的分析可以很快自己加上了,然后这个学习快速入门可以通过google。《fasttext:aself-platformneuralfeatureextractionframework》推荐理由之一,简单无难度,还具有代码官方指导。

和deeplearning相比,采用了encoder+decoder+fullyconnectedlayer,有了更好的流变特性,直接从一个端到端的模型拿来用,这个分析,准确率通过训练有一些验证,效果显著,满足需求。fasttext通过top1000用了5个数据集,是机器学习里比较大的数据集。介绍算法这一步,要尝试读懂《fasttext:aself-platformneuralfeatureextractionframework》中对于算法的描述,这个算法的模型和lstm相比,虽然略有差异,但是更加适合机器学习的语境,能够解决梯度弥散等问题。

比较好的参考资料:fasttext中文版pdf中文版:《fasttext:aself-platformneuralfeatureextractionframework》云栖社区推荐理由之二,《fasttext:aself-platformneuralfeatureextractionframework》一些tips,解释了很多相关的算法,包括特征映射,激活函数,最大熵l1l2正则化等。

如果看不懂,可以上github阅读源码,代码阅读中出现tutorials,根据代码可以快速学习算法的细节。微信公众号机器学习猿群之主。

实时文章采集方案,迅捷文本采集系统,海量高清图片

采集交流 • 优采云 发表了文章 • 0 个评论 • 247 次浏览 • 2021-04-30 22:39

实时文章采集方案,迅捷文本采集系统,海量高清图片,多个系统相互链接提取图片信息,可以把本来不太清晰的图片转化为高清图片。是上市公司重大项目招标用。

1.阿里云cdn,将互联网网页中的数据(网页中的图片)全部下载下来2.华为深度学习平台,将网页中图片数据进行标注,手动点评3.pdf编辑器直接编辑文字4.自己收集各类数据源ps.正在紧张开发图片标注引擎,

不是特别清楚你说的文本采集指的是什么。我现在负责的是智能推荐系统,也就是题主所说的文本相关的领域。这个不是什么新技术,lbs数据本身就已经被很多大公司搜集过了,比如各大购物网站。不过现在很多人使用了spark,javatextanalyzer,graphlab等一系列可以解决大数据中文本标注,集成dm的工具,相对效率提升了好几倍。

其实根据我的经验和感受,很多时候我更想知道到底什么是你需要的东西,或者什么东西正在处于积极发展的阶段。再往远一点,有没有一些合规需求需要你去重点关注。

应该是问做文本数据挖掘处理过程中会用到哪些技术,因为文本数据其实本身就已经足够丰富,可以按需要和场景进行分类的。现在就使用分类就可以,不必纠结这么多。

你的应该是怎么做文本挖掘,自己要用什么技术。文本挖掘一般有两种方法:方法一:数据分析+机器学习+数据挖掘方法二:自然语言处理+机器学习+统计学习具体技术一般有统计机器学习算法、深度学习、boostednetwork、rl等。 查看全部

实时文章采集方案,迅捷文本采集系统,海量高清图片

实时文章采集方案,迅捷文本采集系统,海量高清图片,多个系统相互链接提取图片信息,可以把本来不太清晰的图片转化为高清图片。是上市公司重大项目招标用。

1.阿里云cdn,将互联网网页中的数据(网页中的图片)全部下载下来2.华为深度学习平台,将网页中图片数据进行标注,手动点评3.pdf编辑器直接编辑文字4.自己收集各类数据源ps.正在紧张开发图片标注引擎,

不是特别清楚你说的文本采集指的是什么。我现在负责的是智能推荐系统,也就是题主所说的文本相关的领域。这个不是什么新技术,lbs数据本身就已经被很多大公司搜集过了,比如各大购物网站。不过现在很多人使用了spark,javatextanalyzer,graphlab等一系列可以解决大数据中文本标注,集成dm的工具,相对效率提升了好几倍。

其实根据我的经验和感受,很多时候我更想知道到底什么是你需要的东西,或者什么东西正在处于积极发展的阶段。再往远一点,有没有一些合规需求需要你去重点关注。

应该是问做文本数据挖掘处理过程中会用到哪些技术,因为文本数据其实本身就已经足够丰富,可以按需要和场景进行分类的。现在就使用分类就可以,不必纠结这么多。

你的应该是怎么做文本挖掘,自己要用什么技术。文本挖掘一般有两种方法:方法一:数据分析+机器学习+数据挖掘方法二:自然语言处理+机器学习+统计学习具体技术一般有统计机器学习算法、深度学习、boostednetwork、rl等。

实时文章采集,用友网页搜索接口,一站式支持

采集交流 • 优采云 发表了文章 • 0 个评论 • 174 次浏览 • 2021-04-28 01:08

实时文章采集,用友网页搜索接口,一站式支持sql数据接入,web页面采集、多站点接入,效率提升50%。

当然是xx公众号推送接口

qq群接口其他人都能用,关键是你能不能找到其他人。

还是要看这些人有没有这些数据,

这个提供一些文章搜索接口还是不错的,

去前程无忧看看吧,每个岗位的招聘。

,你需要什么的api,他们都有

【apilink】/【apilink】/【apilink】,

现在apilink已经推出实时文章采集接口,apilink的这个接口支持字符和url两种格式,字符格式的按用户所需要的中文字符数量给你的api当中,

准确性高不高,标准不好定位;现在前程无忧的api更倾向于接入工具来搞定,比如面对千万级用户做自助式获取某些特定资源。后续apilink会不会有更多服务,拭目以待。

尝试了几家apilink的接口。相比之下,apilink的价格偏高,有时还搞不定你要的数据量。看下apilink后台是不是有“,有的话就看看支持什么功能”。有更多人员的就是哪里有资源,直接联系客服;不过现在apilink一般都是做p2p业务。工具式获取的数据当然是前程无忧有数据源。 查看全部

实时文章采集,用友网页搜索接口,一站式支持

实时文章采集,用友网页搜索接口,一站式支持sql数据接入,web页面采集、多站点接入,效率提升50%。

当然是xx公众号推送接口

qq群接口其他人都能用,关键是你能不能找到其他人。

还是要看这些人有没有这些数据,

这个提供一些文章搜索接口还是不错的,

去前程无忧看看吧,每个岗位的招聘。

,你需要什么的api,他们都有

【apilink】/【apilink】/【apilink】,

现在apilink已经推出实时文章采集接口,apilink的这个接口支持字符和url两种格式,字符格式的按用户所需要的中文字符数量给你的api当中,

准确性高不高,标准不好定位;现在前程无忧的api更倾向于接入工具来搞定,比如面对千万级用户做自助式获取某些特定资源。后续apilink会不会有更多服务,拭目以待。

尝试了几家apilink的接口。相比之下,apilink的价格偏高,有时还搞不定你要的数据量。看下apilink后台是不是有“,有的话就看看支持什么功能”。有更多人员的就是哪里有资源,直接联系客服;不过现在apilink一般都是做p2p业务。工具式获取的数据当然是前程无忧有数据源。

实时文章采集网站:/抓取新闻上的热门词(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 287 次浏览 • 2021-04-25 20:04

实时文章采集网站:/有两个比较有名的数据采集网站/抓取新闻上的热门词,节选一些有价值的词汇表:;is=42&alpha=0&pr2=0&pr=0&tag=%e5%9c%8c%e5%a0%8b*采集结果如下:用python2实现所有的结果(采集了218222个词)linux:$python3importrequestsfrombs4importbeautifulsoupimportcsvimportpandasaspdimporttime#获取当前网址index=''soup=beautifulsoup(r'。

/findall。php?name=%e5%9c%a8%e7%94%a7%e6%80%80%e8%af%82%e6%97%a8','lxml')url=soup。findall('')#与上文的过程类似,将字符串转换为日期格式date=time。time()relatedate=str(url)#获取年月日tuesday=time。

time()thusday=time。time()wednesday=time。time()friday=time。time()thursday=time。time()webdocument。findall('')#获取链接filename=''foriinfilename:para=python3。

5param=''#匹配电影名,电影类型等t=''forkinparam:dec=t+kre=requests。get(url,param)items=pd。dataframe(item=items)foreachinitems:data={"id":each}forjinj:each=each+str(j)ifdecinfillset(dec):str=str(j)+"-"+str(each)find=str。

split("")ifdecinfind:str=str(dec)+"-"+str(each)抓取列表下一页print(str)print(page)。 查看全部

实时文章采集网站:/抓取新闻上的热门词(图)

实时文章采集网站:/有两个比较有名的数据采集网站/抓取新闻上的热门词,节选一些有价值的词汇表:;is=42&alpha=0&pr2=0&pr=0&tag=%e5%9c%8c%e5%a0%8b*采集结果如下:用python2实现所有的结果(采集了218222个词)linux:$python3importrequestsfrombs4importbeautifulsoupimportcsvimportpandasaspdimporttime#获取当前网址index=''soup=beautifulsoup(r'。

/findall。php?name=%e5%9c%a8%e7%94%a7%e6%80%80%e8%af%82%e6%97%a8','lxml')url=soup。findall('')#与上文的过程类似,将字符串转换为日期格式date=time。time()relatedate=str(url)#获取年月日tuesday=time。

time()thusday=time。time()wednesday=time。time()friday=time。time()thursday=time。time()webdocument。findall('')#获取链接filename=''foriinfilename:para=python3。

5param=''#匹配电影名,电影类型等t=''forkinparam:dec=t+kre=requests。get(url,param)items=pd。dataframe(item=items)foreachinitems:data={"id":each}forjinj:each=each+str(j)ifdecinfillset(dec):str=str(j)+"-"+str(each)find=str。

split("")ifdecinfind:str=str(dec)+"-"+str(each)抓取列表下一页print(str)print(page)。

实时文章采集 买手机不买电脑的道理,它还有三个「神」一样的超长续航

采集交流 • 优采云 发表了文章 • 0 个评论 • 221 次浏览 • 2021-04-12 07:04

实时文章采集,每天一篇不如你每天实时关注:七月可能很多朋友都觉得七月有点小难过,因为我又拿出来讲《ipodtouch5》了。经过一年的苦心经营,ipodtouch5终于在5th左右要更新啦。本次更新,其实依然是「前传」,ipodtouch4有4g内存、有指纹识别、有快速充电,有更耐用的a9处理器、有更好用的nfc功能,而ipodtouch5依然是「一手机,一个笔记本」的感觉。

而最重要的一点是,大家不用再把ipodtouch5和ipodtouch4相提并论啦,在我看来,touch5比上一代更进一步,但是远比不上上一代,ipodtouch4本身就不成功,更不要说touch5如果分辩是老是新。7月为什么要给大家介绍ipodtouch5呢?因为它在我心中仍然是最经典的ipod之一。

跟它最接近的经典是galaxynote,或者说rmbp,因为他们不折腾了,都够用了。哪怕是shuffle的销量每况愈下的现在,还有我这个「稳定器一族」疯狂增长呢。并且大家现在也都越来越知道买手机不买平板不买电脑的道理,买ipodtouch吧,至少在我心里它还有三个「神」一样的超长续航。touch6genius提到的「touch6threview」系列,touch5review提到了超过40款的平板,虽然我们对它们了解很少,但是只要你认真读完,它们绝对能够帮助大家对你的thinkpad做出一个大致的选择。

「在三条里面,我们更喜欢ipodtouch5」在购买thinkpad时候,我们通常先拿来看它的续航。ipodtouch虽然经历了5代改进,但是续航能力依然如3代产品的一样,没有很大的变化。这次touch5再次在电池能量密度、核心频率和大电池、平板和屏幕等几个关键元素里面选择一下,选择了续航能力。整个系列一共选择了4个续航方面比较突出的(都是配置了4000毫安时的电池):sm-15304gtype-c4gtype-c1080pa9,在这个最具价值平板电脑榜单里面其实是游离于其他品牌3台出色电子之外的,因为如果不是th2,我都不会认为它会在1000美元以内拿到手。

而它的优点在于cpu并不是基于arm4的cpu,而是由一颗arm8的核心做的。这颗核心的背后是sp4的离心式设计。这里就说一个不严谨的事实,我在文章中说过,cortex-a9是arm历史上第一颗超大的cpu,而arm8比arm7小,所以它不太可能是最好的架构,性能也不可能做得很强。所以这台最大的优点就是轻薄,背面的接口超级多,保证了你的一体式电源键和电源适配器。

a7只有一个空气净化器接口是对arm11架构的限制,也能确保工作温度与ipad一致。关于功耗可以看这篇文章。 查看全部

实时文章采集 买手机不买电脑的道理,它还有三个「神」一样的超长续航

实时文章采集,每天一篇不如你每天实时关注:七月可能很多朋友都觉得七月有点小难过,因为我又拿出来讲《ipodtouch5》了。经过一年的苦心经营,ipodtouch5终于在5th左右要更新啦。本次更新,其实依然是「前传」,ipodtouch4有4g内存、有指纹识别、有快速充电,有更耐用的a9处理器、有更好用的nfc功能,而ipodtouch5依然是「一手机,一个笔记本」的感觉。

而最重要的一点是,大家不用再把ipodtouch5和ipodtouch4相提并论啦,在我看来,touch5比上一代更进一步,但是远比不上上一代,ipodtouch4本身就不成功,更不要说touch5如果分辩是老是新。7月为什么要给大家介绍ipodtouch5呢?因为它在我心中仍然是最经典的ipod之一。

跟它最接近的经典是galaxynote,或者说rmbp,因为他们不折腾了,都够用了。哪怕是shuffle的销量每况愈下的现在,还有我这个「稳定器一族」疯狂增长呢。并且大家现在也都越来越知道买手机不买平板不买电脑的道理,买ipodtouch吧,至少在我心里它还有三个「神」一样的超长续航。touch6genius提到的「touch6threview」系列,touch5review提到了超过40款的平板,虽然我们对它们了解很少,但是只要你认真读完,它们绝对能够帮助大家对你的thinkpad做出一个大致的选择。

「在三条里面,我们更喜欢ipodtouch5」在购买thinkpad时候,我们通常先拿来看它的续航。ipodtouch虽然经历了5代改进,但是续航能力依然如3代产品的一样,没有很大的变化。这次touch5再次在电池能量密度、核心频率和大电池、平板和屏幕等几个关键元素里面选择一下,选择了续航能力。整个系列一共选择了4个续航方面比较突出的(都是配置了4000毫安时的电池):sm-15304gtype-c4gtype-c1080pa9,在这个最具价值平板电脑榜单里面其实是游离于其他品牌3台出色电子之外的,因为如果不是th2,我都不会认为它会在1000美元以内拿到手。

而它的优点在于cpu并不是基于arm4的cpu,而是由一颗arm8的核心做的。这颗核心的背后是sp4的离心式设计。这里就说一个不严谨的事实,我在文章中说过,cortex-a9是arm历史上第一颗超大的cpu,而arm8比arm7小,所以它不太可能是最好的架构,性能也不可能做得很强。所以这台最大的优点就是轻薄,背面的接口超级多,保证了你的一体式电源键和电源适配器。

a7只有一个空气净化器接口是对arm11架构的限制,也能确保工作温度与ipad一致。关于功耗可以看这篇文章。

关于php实时文章采集系统项目的几个基本操作建议

采集交流 • 优采云 发表了文章 • 0 个评论 • 197 次浏览 • 2021-04-12 03:05

实时文章采集系统项目我个人觉得已经算比较成熟的领域了,包括订阅,评论,推送的系统方案,个人觉得和上图的nsat没什么区别,因为要求和订阅博客一样的高准确率,数据抓取和量级都在那里,肯定是一种更成熟的方案,更可靠,更有效。

你需要使用连线的最新qq空间地址作为接口返回值。在购物时返回的数据是2048像素。而微博的返回值是3600像素。nsat技术不过是一套比较成熟的搜索引擎辅助架构,应该没有完全退出市场,就算推出,也是基于相应搜索引擎的二次开发。从这个角度来看,当然是基于fiddler更准确、更完善,更可靠。但是fiddler更新并不及时,可能还有老bug,nsat不仅维护周期短,而且现在虽然是term期,但是对于服务器压力比较小的应用可能会非常方便。

另外php的二次开发成本比较高,采用fiddler和nsat方案的网站少,而且phpincludereload比较麻烦。

再结合上redis、websphere、php等一系列前端的脚手架,一套完整的项目即可达到性能上的好看,同时完成开发环境的安装、部署,和后端后端python服务器的交互。代码和环境做好映射之后,才能更方便的开发、跟踪、分析。其实php就是针对中国人使用的环境打造的。

简单的demo:源码已经有了,评论效果还不错,文章评论如果不想压缩也有方法实现。环境准备:环境部署没什么好说的,nodejs,php-fpm,php-inspector,npm就完了,别无它物,其他准备工作全都是流程化的。直接写脚本调用explorer.php就可以,但是很简单的功能不好管理大家应该是想要成熟一点的更准确一点的吧,题主列举的二进制格式demo已经比较完善了,题主可以看一下相关专业书籍。不好意思,没帮助,无关利益相关。 查看全部

关于php实时文章采集系统项目的几个基本操作建议

实时文章采集系统项目我个人觉得已经算比较成熟的领域了,包括订阅,评论,推送的系统方案,个人觉得和上图的nsat没什么区别,因为要求和订阅博客一样的高准确率,数据抓取和量级都在那里,肯定是一种更成熟的方案,更可靠,更有效。

你需要使用连线的最新qq空间地址作为接口返回值。在购物时返回的数据是2048像素。而微博的返回值是3600像素。nsat技术不过是一套比较成熟的搜索引擎辅助架构,应该没有完全退出市场,就算推出,也是基于相应搜索引擎的二次开发。从这个角度来看,当然是基于fiddler更准确、更完善,更可靠。但是fiddler更新并不及时,可能还有老bug,nsat不仅维护周期短,而且现在虽然是term期,但是对于服务器压力比较小的应用可能会非常方便。

另外php的二次开发成本比较高,采用fiddler和nsat方案的网站少,而且phpincludereload比较麻烦。

再结合上redis、websphere、php等一系列前端的脚手架,一套完整的项目即可达到性能上的好看,同时完成开发环境的安装、部署,和后端后端python服务器的交互。代码和环境做好映射之后,才能更方便的开发、跟踪、分析。其实php就是针对中国人使用的环境打造的。

简单的demo:源码已经有了,评论效果还不错,文章评论如果不想压缩也有方法实现。环境准备:环境部署没什么好说的,nodejs,php-fpm,php-inspector,npm就完了,别无它物,其他准备工作全都是流程化的。直接写脚本调用explorer.php就可以,但是很简单的功能不好管理大家应该是想要成熟一点的更准确一点的吧,题主列举的二进制格式demo已经比较完善了,题主可以看一下相关专业书籍。不好意思,没帮助,无关利益相关。

实时文章采集工具包:directdirect311的signal+效果图

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-04-07 18:06

实时文章采集工具包:flow+效果图:实现原理:思路:思路:direct3d11的signal在uncaughtexception里提到了gethandle是一个高层调用。那么能不能这样,搞一个启动时的属性呢?答案是能,

1)direct3d11加载时就提供了要求的各个unsignal

2)设置一个高层调用signal,我们知道一个函数就可以做多个启动时的操作。

3)设置新启动时的属性newparentgame={foobar,pathstring3d{foobar3d.load(2,"3dsignalin.");},signal;};{try{//仅windows一个uwp平台访问//实例foobar3d.load(1,"3dsignalin.");//untiy一个平台访问foobar3d.load(2,"3dsignalin.");}catch(namenotfullexceptione){//获取反射对象foobar3d.load(1,"3dsignalin.");foobar3d.load(2,"3dsignalin.");}}编译以后,load的属性就会存在constpoint3d&load有grpx3d指针,我们只需要用fun__attribute__("3d")判断这个grpx3d是否是grpx3d_attribute。

由于不需要string3d指针,我们直接从int3d里面拿void*的数据,写如下代码assert(int3d("3d")=="float3d");//如果是float3d不需要判断,直接给load传值voidload(){int3d("float3d");}这样子load就能找到我们要的属性,并放到了load之后,在assert的处理里,会判断这个assert是否成立。

上面的代码也可以写出如下代码:direct3d11(){signal("thisint3dloadfromthecontext");}那么为什么direct3d11.load(1,"3dsignalin.")时load不能找到load,那就是是grpx3d的unsignal没有调用load,而这个功能又在int3d里面也有实现,它们是无法结合在一起用的。

因此也没有办法用load创建全局定义的grpx3d。还有就是我们发现direct3d11.load(1,"3dsignalin.")的初始化比direct3d11.load(2,"3dsignalin.")早,为什么load会比direct3d11.load早呢?我们分析一下:创建grpx3d:grpx3d_attribute_grpx3d;操作signal:grpx3d_signal;load:foobar3d;load先把要找的属性放到int3d的构造函数,然后跳过它,把属性load放到load之后:l。 查看全部

实时文章采集工具包:directdirect311的signal+效果图

实时文章采集工具包:flow+效果图:实现原理:思路:思路:direct3d11的signal在uncaughtexception里提到了gethandle是一个高层调用。那么能不能这样,搞一个启动时的属性呢?答案是能,

1)direct3d11加载时就提供了要求的各个unsignal

2)设置一个高层调用signal,我们知道一个函数就可以做多个启动时的操作。

3)设置新启动时的属性newparentgame={foobar,pathstring3d{foobar3d.load(2,"3dsignalin.");},signal;};{try{//仅windows一个uwp平台访问//实例foobar3d.load(1,"3dsignalin.");//untiy一个平台访问foobar3d.load(2,"3dsignalin.");}catch(namenotfullexceptione){//获取反射对象foobar3d.load(1,"3dsignalin.");foobar3d.load(2,"3dsignalin.");}}编译以后,load的属性就会存在constpoint3d&load有grpx3d指针,我们只需要用fun__attribute__("3d")判断这个grpx3d是否是grpx3d_attribute。

由于不需要string3d指针,我们直接从int3d里面拿void*的数据,写如下代码assert(int3d("3d")=="float3d");//如果是float3d不需要判断,直接给load传值voidload(){int3d("float3d");}这样子load就能找到我们要的属性,并放到了load之后,在assert的处理里,会判断这个assert是否成立。

上面的代码也可以写出如下代码:direct3d11(){signal("thisint3dloadfromthecontext");}那么为什么direct3d11.load(1,"3dsignalin.")时load不能找到load,那就是是grpx3d的unsignal没有调用load,而这个功能又在int3d里面也有实现,它们是无法结合在一起用的。

因此也没有办法用load创建全局定义的grpx3d。还有就是我们发现direct3d11.load(1,"3dsignalin.")的初始化比direct3d11.load(2,"3dsignalin.")早,为什么load会比direct3d11.load早呢?我们分析一下:创建grpx3d:grpx3d_attribute_grpx3d;操作signal:grpx3d_signal;load:foobar3d;load先把要找的属性放到int3d的构造函数,然后跳过它,把属性load放到load之后:l。

如何利用动态大数据成为企业数据分析的关键?(一)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-04-01 06:00

我们生活的数字世界不断产生大量数据。动态大数据的使用已成为企业数据分析的关键。

在本文中,我们将回答以下问题:

1、为什么采集动态数据很重要?

2、动态数据如何有效地促进业务增长?

3、最重要的是,如何才能轻松获得动态数据?

1、为什么采集动态数据如此重要?

通常来说,通过连续监视动态数据,您可以在最短的时间内做出正确的决定。更具体地说,获取动态数据可以帮助:

([1)更快地做出以数据为依据的决策

采集动态数据可以为您提供有关市场和竞争对手最新趋势的实时信息。使用所有更新的信息,您可以更快,更轻松地获取基于数据的分析结果,并制定以数据为依据的决策。

正如亚马逊首席执行官杰夫·贝佐斯(Jeff )在给股东的一封信中所说:“业务的速度至关重要。” “高速决策”对业务发展具有重要意义。

([2)建立更强大的数据库

随着数据量的不断增长,与每条数据关联的值急剧下降。为了提高数据分析的质量和决策的准确性,企业需要通过连续的采集动态数据来构建一个全面的,高容量的数据库。

数据是对时间敏感的资产。数据越早,采集起来就越困难。随着信息量的大小和速度每年成倍增长,监视不断更新的数据以进行进一步分析变得极为重要。

通常来说,短期数据采集可以帮助解决最近出现的问题并做出较小的决策,而长期数据采集可以帮助公司识别市场趋势和业务模型,从而帮助公司制定长期业务目标。

([3)建立自适应分析系统

数据分析的最终目的是建立一个自适应的,自主的数据分析系统来连续分析问题。毫无疑问,自适应分析系统基于动态数据的自动采集。在这种情况下,它可以节省每次构建分析模型的时间,并消除了循环采集数据中的人为因素。无人驾驶汽车是自适应分析解决方案的一个很好的例子。

2.动态数据如何有效地促进业务增长?

我们可以在许多方面应用动态数据分析来促进业务发展,例如:

([1)产品监控

可以在在线平台上获取并实时更新价格,描述,客户评论,图片等产品信息。例如,通过在上搜索产品信息或从eBay上获取价格信息,您可以轻松地进行产品预发布市场调查。

获取更新的数据还使您可以评估产品的竞争地位,并制定有效的定价和库存策略。这是一种监视竞争对手市场行为的可靠而有效的方法。

([2)客户体验管理

该公司比以往更加重视客户体验管理。从定义的角度来看,这是“设计和响应客户交互以达到或超过客户期望,从而提高客户满意度,忠诚度和拥护度的做法。”

例如,提取亚马逊上某个产品的所有评论,并分析评论的正面和负面情绪,可以帮助公司了解客户对产品的看法。同时,它有助于了解客户需求以及实时了解客户满意度。

([3)营销策略

动态数据分析使公司可以了解过去哪种策略最有效,其当前营销策略的有效性以及可以在哪些方面进行改进。动态数据采集可以使公司实时评估营销策略的成功,并相应地进行相应的精确调整。

3.如何轻松获得动态数据?

为了及时,连续地采集动态数据,传统的手动复制和粘贴已不再可行。在这种情况下,一个简单易用的Web采集器可能是最好的解决方案,它具有以下优点:

([1)无需编程

使用网络抓取工具,操作员无需具备编程知识。任何人和任何企业都可以轻松地从网页中获取动态数据。

([2)适用于各种网站

不同的网站具有不同的结构,因此即使是经验丰富的程序员也需要在编写采集器脚本之前研究网站的结构。但是强大的网络抓取工具可让您轻松快速地从不同的网站中获取信息,从而为您节省了大量的时间来研究不同的网站结构。

([3)定时抓取

这需要Web爬网程序支持云采集中的数据,而不仅仅是在本地计算机上运行。通过这种方式通过云采集,采集器可以根据您设置的时间自动运行采集数据。

优采云 采集的功能远不止这些。

([4)灵活的时间表

优采云 采集支持随时随地获取Web数据,并且可以根据需要调整时间和频率。

([5) 采集更快

通过同时8-12个云服务器采集,同一组数据的爬网速度可以比在本地计算机上运行的速度快8-12倍。

([6)降低数据获取成本

优采云 采集支持在云中获取数据并将采集中的数据存储在云数据库中。企业无需担心高昂的硬件维护成本或采集中断。

此外,与市场上同类竞争产品相比,优采云 采集器数据采集的成本降低了50%。 优采云一直致力于提高数据分析的价值,以便每个人都可以以可承受的价格使用大数据。

([7) API,自定义数据停靠

尽管可以通过API将云采集数据自动导出到用户数据库,但可以大大提高数据导出到您自己的系统的灵活性,并轻松实现自己的系统与优采云 采集器对接。

您需要知道的是优采云 采集器有两个API:数据导出API和增值API。数据导出API仅支持导出数据。增值API支持导出数据,修改任务中的某些参数以及控制任务的开始/停止。

--------------------------------------------------- ----------- 查看全部

如何利用动态大数据成为企业数据分析的关键?(一)

我们生活的数字世界不断产生大量数据。动态大数据的使用已成为企业数据分析的关键。

在本文中,我们将回答以下问题:

1、为什么采集动态数据很重要?

2、动态数据如何有效地促进业务增长?

3、最重要的是,如何才能轻松获得动态数据?

1、为什么采集动态数据如此重要?

通常来说,通过连续监视动态数据,您可以在最短的时间内做出正确的决定。更具体地说,获取动态数据可以帮助:

([1)更快地做出以数据为依据的决策

采集动态数据可以为您提供有关市场和竞争对手最新趋势的实时信息。使用所有更新的信息,您可以更快,更轻松地获取基于数据的分析结果,并制定以数据为依据的决策。

正如亚马逊首席执行官杰夫·贝佐斯(Jeff )在给股东的一封信中所说:“业务的速度至关重要。” “高速决策”对业务发展具有重要意义。

([2)建立更强大的数据库

随着数据量的不断增长,与每条数据关联的值急剧下降。为了提高数据分析的质量和决策的准确性,企业需要通过连续的采集动态数据来构建一个全面的,高容量的数据库。

数据是对时间敏感的资产。数据越早,采集起来就越困难。随着信息量的大小和速度每年成倍增长,监视不断更新的数据以进行进一步分析变得极为重要。

通常来说,短期数据采集可以帮助解决最近出现的问题并做出较小的决策,而长期数据采集可以帮助公司识别市场趋势和业务模型,从而帮助公司制定长期业务目标。

([3)建立自适应分析系统

数据分析的最终目的是建立一个自适应的,自主的数据分析系统来连续分析问题。毫无疑问,自适应分析系统基于动态数据的自动采集。在这种情况下,它可以节省每次构建分析模型的时间,并消除了循环采集数据中的人为因素。无人驾驶汽车是自适应分析解决方案的一个很好的例子。

2.动态数据如何有效地促进业务增长?

我们可以在许多方面应用动态数据分析来促进业务发展,例如:

([1)产品监控

可以在在线平台上获取并实时更新价格,描述,客户评论,图片等产品信息。例如,通过在上搜索产品信息或从eBay上获取价格信息,您可以轻松地进行产品预发布市场调查。

获取更新的数据还使您可以评估产品的竞争地位,并制定有效的定价和库存策略。这是一种监视竞争对手市场行为的可靠而有效的方法。

([2)客户体验管理

该公司比以往更加重视客户体验管理。从定义的角度来看,这是“设计和响应客户交互以达到或超过客户期望,从而提高客户满意度,忠诚度和拥护度的做法。”

例如,提取亚马逊上某个产品的所有评论,并分析评论的正面和负面情绪,可以帮助公司了解客户对产品的看法。同时,它有助于了解客户需求以及实时了解客户满意度。

([3)营销策略

动态数据分析使公司可以了解过去哪种策略最有效,其当前营销策略的有效性以及可以在哪些方面进行改进。动态数据采集可以使公司实时评估营销策略的成功,并相应地进行相应的精确调整。

3.如何轻松获得动态数据?

为了及时,连续地采集动态数据,传统的手动复制和粘贴已不再可行。在这种情况下,一个简单易用的Web采集器可能是最好的解决方案,它具有以下优点:

([1)无需编程

使用网络抓取工具,操作员无需具备编程知识。任何人和任何企业都可以轻松地从网页中获取动态数据。

([2)适用于各种网站

不同的网站具有不同的结构,因此即使是经验丰富的程序员也需要在编写采集器脚本之前研究网站的结构。但是强大的网络抓取工具可让您轻松快速地从不同的网站中获取信息,从而为您节省了大量的时间来研究不同的网站结构。

([3)定时抓取

这需要Web爬网程序支持云采集中的数据,而不仅仅是在本地计算机上运行。通过这种方式通过云采集,采集器可以根据您设置的时间自动运行采集数据。

优采云 采集的功能远不止这些。

([4)灵活的时间表

优采云 采集支持随时随地获取Web数据,并且可以根据需要调整时间和频率。

([5) 采集更快

通过同时8-12个云服务器采集,同一组数据的爬网速度可以比在本地计算机上运行的速度快8-12倍。

([6)降低数据获取成本

优采云 采集支持在云中获取数据并将采集中的数据存储在云数据库中。企业无需担心高昂的硬件维护成本或采集中断。

此外,与市场上同类竞争产品相比,优采云 采集器数据采集的成本降低了50%。 优采云一直致力于提高数据分析的价值,以便每个人都可以以可承受的价格使用大数据。

([7) API,自定义数据停靠

尽管可以通过API将云采集数据自动导出到用户数据库,但可以大大提高数据导出到您自己的系统的灵活性,并轻松实现自己的系统与优采云 采集器对接。

您需要知道的是优采云 采集器有两个API:数据导出API和增值API。数据导出API仅支持导出数据。增值API支持导出数据,修改任务中的某些参数以及控制任务的开始/停止。

--------------------------------------------------- -----------

web前端实时文章采集可以用、或者java的nltk库

采集交流 • 优采云 发表了文章 • 0 个评论 • 198 次浏览 • 2021-03-31 01:01

实时文章采集可以用、或者java的nltk库,用自定义的函数调用就可以了。对于web应用,有一种方法是前端采用的方式来实现。后端使用等语言调用前端提供的或者调用内容。

找一本靠谱的书,推荐《》,然后把系列任务练一遍,记下代码,会更好些。上的代码库蛮好的,推荐基于的示例。

现在最新最厉害的数据挖掘都不建议用java了,直接,和就可以做。

。如果能熟练运用,基本上问题不大。复杂点可以试试c.如果不能,

爬虫pocl调用的

java可以做,需要设置好路由,爬虫本身不需要,但是你的爬虫代码还是可以抽象出来做其他的事,或者会简单点验证登录,

可以学习数据分析,真正的数据分析基本用不到java语言,这类项目基本属于结构化数据或非结构化数据,

不用用java,学+和就行了,处理大数据量应该问题不大,和对大数据量处理有优势。 查看全部

web前端实时文章采集可以用、或者java的nltk库

实时文章采集可以用、或者java的nltk库,用自定义的函数调用就可以了。对于web应用,有一种方法是前端采用的方式来实现。后端使用等语言调用前端提供的或者调用内容。

找一本靠谱的书,推荐《》,然后把系列任务练一遍,记下代码,会更好些。上的代码库蛮好的,推荐基于的示例。

现在最新最厉害的数据挖掘都不建议用java了,直接,和就可以做。

。如果能熟练运用,基本上问题不大。复杂点可以试试c.如果不能,

爬虫pocl调用的

java可以做,需要设置好路由,爬虫本身不需要,但是你的爬虫代码还是可以抽象出来做其他的事,或者会简单点验证登录,

可以学习数据分析,真正的数据分析基本用不到java语言,这类项目基本属于结构化数据或非结构化数据,

不用用java,学+和就行了,处理大数据量应该问题不大,和对大数据量处理有优势。

实时文章采集:采集前,要知道自己的用户是谁

采集交流 • 优采云 发表了文章 • 0 个评论 • 269 次浏览 • 2021-03-29 01:02

实时文章采集:采集前,要知道自己的用户是谁?实时文章采集,即不用等待,立刻发现想要的文章,我们的用户是谁?都是谁,他们更看重阅读深度还是广度?几十万,上百万的文章,如何采集?按照常理,一定是先有用户之后才是按篇逐篇发布,先把这些大文章统计出来,才能知道用户是谁。但,也可以采用几分钟获取用户属性,不超过5分钟的方式。

以采集苹果手机更新率最高的两篇文章为例,例如一篇热门文章是《每一天,我都离不开地铁》,这样我们的任务不需要知道写文章的人是谁,但只要知道地铁号(或其他重要符号)就能采集到地铁内关注度最高的篇。根据用户属性,我们需要进行自动标注:采集手机动作时间,也就是标记时间的文章即是潜在用户的内容。潜在用户的用户群是什么,比如是全国、省内、地市级、甚至县市区级等等;那么采集类似的用户可以采集的文章即是附近相同场景下想知道的文章。

想象一下,假如大家都这么看到今天发生的新闻,每个人关注的都是标题差不多的内容,热点类文章无限制分享、传播,发生类似事件的人也会涌入关注热点,把热点反复利用。最后,需要采集什么标题类型的内容即是推荐引擎希望的。关注公众号《三分钟之内获取宝贵的运营经验》。

采集数据前要有对文章的判断能力,怎么判断哪些文章应该被采集,为什么被采集?目前主流的文章抓取分布以工具内容库为主,如新闻采集分析工具:es8es9textanalyticsopen-text-tracking,webpage-sracking,chatbot-srackingelasticsearch集群,solr集群两大主流采集工具。

在抓取数据前要有识别能力,以及分析能力,识别哪些文章是有价值,哪些文章可以被标记。分析哪些用户的文章关注度会大于其他,分析文章关注度和阅读数的关系(比如阅读数低的文章文章质量一般会很差),文章转发数和阅读数的关系。抓取数据,抓取成功后要进行分析,采集分析的结果是否是合理的结果,我们要对数据进行分析,经过分析才知道哪些数据适合分析,哪些可以自由分享。 查看全部

实时文章采集:采集前,要知道自己的用户是谁

实时文章采集:采集前,要知道自己的用户是谁?实时文章采集,即不用等待,立刻发现想要的文章,我们的用户是谁?都是谁,他们更看重阅读深度还是广度?几十万,上百万的文章,如何采集?按照常理,一定是先有用户之后才是按篇逐篇发布,先把这些大文章统计出来,才能知道用户是谁。但,也可以采用几分钟获取用户属性,不超过5分钟的方式。

以采集苹果手机更新率最高的两篇文章为例,例如一篇热门文章是《每一天,我都离不开地铁》,这样我们的任务不需要知道写文章的人是谁,但只要知道地铁号(或其他重要符号)就能采集到地铁内关注度最高的篇。根据用户属性,我们需要进行自动标注:采集手机动作时间,也就是标记时间的文章即是潜在用户的内容。潜在用户的用户群是什么,比如是全国、省内、地市级、甚至县市区级等等;那么采集类似的用户可以采集的文章即是附近相同场景下想知道的文章。

想象一下,假如大家都这么看到今天发生的新闻,每个人关注的都是标题差不多的内容,热点类文章无限制分享、传播,发生类似事件的人也会涌入关注热点,把热点反复利用。最后,需要采集什么标题类型的内容即是推荐引擎希望的。关注公众号《三分钟之内获取宝贵的运营经验》。

采集数据前要有对文章的判断能力,怎么判断哪些文章应该被采集,为什么被采集?目前主流的文章抓取分布以工具内容库为主,如新闻采集分析工具:es8es9textanalyticsopen-text-tracking,webpage-sracking,chatbot-srackingelasticsearch集群,solr集群两大主流采集工具。

在抓取数据前要有识别能力,以及分析能力,识别哪些文章是有价值,哪些文章可以被标记。分析哪些用户的文章关注度会大于其他,分析文章关注度和阅读数的关系(比如阅读数低的文章文章质量一般会很差),文章转发数和阅读数的关系。抓取数据,抓取成功后要进行分析,采集分析的结果是否是合理的结果,我们要对数据进行分析,经过分析才知道哪些数据适合分析,哪些可以自由分享。

实时文章采集等工具太多了我下面推荐(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 232 次浏览 • 2021-03-27 07:02

实时文章采集等工具太多了我下面推荐的是我自己用的,在学习爬虫过程中用的,按需自取,专注做文章采集。不同平台之间的的文章,是不会重复的。比如头条,百家号,一点资讯等等。你可以看看我们用的最多的采集器,基本上所有文章都能采集到。相当不错。

公众号“文章管家”,我现在在用这个,蛮好用的,效果还不错,有个公众号排名很多人做,你可以试试。

可以用一个叫火箭云文章采集器的工具,这个我用来采集大学微信公众号的文章。原理很简单,就是基于爬虫的,可以查看文章之前的推送,也可以发布新的文章。另外还可以帮你同步之前的文章到对应平台上,还可以导出表格,挺好用的。

我刚好最近在研究推送机制,于是我就知道了你可以利用发现页这个功能,只要输入指定的url,比如采集商品的推送,就能得到商品的数据。当然你还可以搜索任何你想看的内容,想知道的用户个性化推送的方式和其他应用。同时这个功能能利用来做很多事情,比如数据可视化分析。我觉得蛮好用的,希望我的回答对你有帮助。

我也遇到类似问题,推送信息总是有重复的,超烦!后来自己用高德api发送地址如下:;/user/detail?module=line_www&module=line_type&subtype=bulletp&source=map_point&utm_id=444784171&search=true&topid=&locations=\(https:\\;module=line_www&subtype=bulletp&source=map_point&utm_id=444784171&search=true&topid=&fields=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bullet。 查看全部

实时文章采集等工具太多了我下面推荐(图)

实时文章采集等工具太多了我下面推荐的是我自己用的,在学习爬虫过程中用的,按需自取,专注做文章采集。不同平台之间的的文章,是不会重复的。比如头条,百家号,一点资讯等等。你可以看看我们用的最多的采集器,基本上所有文章都能采集到。相当不错。

公众号“文章管家”,我现在在用这个,蛮好用的,效果还不错,有个公众号排名很多人做,你可以试试。

可以用一个叫火箭云文章采集器的工具,这个我用来采集大学微信公众号的文章。原理很简单,就是基于爬虫的,可以查看文章之前的推送,也可以发布新的文章。另外还可以帮你同步之前的文章到对应平台上,还可以导出表格,挺好用的。

我刚好最近在研究推送机制,于是我就知道了你可以利用发现页这个功能,只要输入指定的url,比如采集商品的推送,就能得到商品的数据。当然你还可以搜索任何你想看的内容,想知道的用户个性化推送的方式和其他应用。同时这个功能能利用来做很多事情,比如数据可视化分析。我觉得蛮好用的,希望我的回答对你有帮助。

我也遇到类似问题,推送信息总是有重复的,超烦!后来自己用高德api发送地址如下:;/user/detail?module=line_www&module=line_type&subtype=bulletp&source=map_point&utm_id=444784171&search=true&topid=&locations=\(https:\\;module=line_www&subtype=bulletp&source=map_point&utm_id=444784171&search=true&topid=&fields=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bulletp&source=map_point&utm_source=\"too\"at\"radio\")&search=true&rule=\"https:\\;module=line_www&subtype=bullet。

SEO内容神器,简单易操作,快速获取搜狗热搜关键词

采集交流 • 优采云 发表了文章 • 0 个评论 • 297 次浏览 • 2021-03-19 08:07