完整的采集神器

完整的采集神器(如何利用神器Firebug获取远程链接数据的方法?(上))

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-09-02 14:10

对于做过数据采集的人来说,curl一定会很熟悉。 PHP中虽然有file_get_contents函数可以获取远程链接数据,但是可控性太差。对于采集场景的各种复杂情况,file_get_contents似乎有点无能为力。因此,本文将向您介绍采集神器cURL。

首先添加file_get_contents函数获取远程链接数据的方法。

这段代码会直接使用curl来显示文件内容,但是问题来了,因为curl是PHP的一个扩展,有些主机为了安全会使用curl,在本地调试的时候curl也是关闭的宁外PHP,所以会出现错误,所以这段代码不可取,所以云落给他重写了

修改后的版本是对curl扩展做一个判断,看curl扩展是否在服务器上打开。如果打开,则直接显示文件,如果未打开,则显示提示文本。

虽然问题已解决,但还有一个问题。我只显示一段文字。我不做大事,为什么要写这么多代码? ?

经过一些傻测试,我发现file_get_contents获取远程文件内容的速度并不比curl慢,而且在一些文件较少的情况下可能比curl扩展快很多,所以我又重新写了一遍代码

工具

火狐 + 萤火虫

“工人要想做好自己的工作,就必须磨砺他们的工具。”在分析案例之前,让我们学习一下如何使用神器Firebug来获取我们需要的信息。

使用F12打开Firebug,我们可以得到图片(一)interface:

1、箭头图标是“元素选择”工具。单击一次以突出显示该图标。同时,鼠标在页面内的移动会同时选中HTML菜单中的相应内容。此时点击内容表示该元素被选中,图标高亮取消。如图(二):

萤火虫视图元素

2、控制面板

这里输出的是JS中console.log系列函数的打印

3、HTML

HTML 内容,注意这里看到的不一定是采集 想要解析的。对采集处内容的分析总是靠查看源码(Ctrl+U),这里只是可以快速定位的元素结构,然后选择一个比较特殊的引用,在源码中定位到对应的位置代码。

例如,如果您在 HTML 中看到一个标签

演示

,但是你查看源代码看到的可能是

演示

如果使用前者对采集内容进行正则匹配,则不会得到任何结果。

4、CSS

这里是CSS文件的内容

5、Script

这里是Javascript文件的内容

6、DOM

Dom 节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的。它可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求的内容保留在控制台中,如图(三):

此外,Firefox 还有一个 Tamper 数据扩展,也可以获取请求数据,需要时可以安装使用。

8、Cookies

Cookie 数据

图中(一),你也可以看到下面有很多可选的小菜单项,其中keep是我们要注意的。选择时,即使页面被刷新提交表单,下方内容区的数据仍会保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集请求的时候,主要关心的是“Network”菜单中的请求数据。如有必要,使用“Keep”查看刷新页面的请求数据。您可以在请求前使用“清除”清除以下内容。 .

案例分析

一、简的采集

这里简单的采集指的是采集单页GET请求。如此简单,即使通过file_get_contents函数也能轻松获取页面返回结果。

File_get_contents 代码片段

<p> 查看全部

完整的采集神器(如何利用神器Firebug获取远程链接数据的方法?(上))

对于做过数据采集的人来说,curl一定会很熟悉。 PHP中虽然有file_get_contents函数可以获取远程链接数据,但是可控性太差。对于采集场景的各种复杂情况,file_get_contents似乎有点无能为力。因此,本文将向您介绍采集神器cURL。

首先添加file_get_contents函数获取远程链接数据的方法。

这段代码会直接使用curl来显示文件内容,但是问题来了,因为curl是PHP的一个扩展,有些主机为了安全会使用curl,在本地调试的时候curl也是关闭的宁外PHP,所以会出现错误,所以这段代码不可取,所以云落给他重写了

修改后的版本是对curl扩展做一个判断,看curl扩展是否在服务器上打开。如果打开,则直接显示文件,如果未打开,则显示提示文本。

虽然问题已解决,但还有一个问题。我只显示一段文字。我不做大事,为什么要写这么多代码? ?

经过一些傻测试,我发现file_get_contents获取远程文件内容的速度并不比curl慢,而且在一些文件较少的情况下可能比curl扩展快很多,所以我又重新写了一遍代码

工具

火狐 + 萤火虫

“工人要想做好自己的工作,就必须磨砺他们的工具。”在分析案例之前,让我们学习一下如何使用神器Firebug来获取我们需要的信息。

使用F12打开Firebug,我们可以得到图片(一)interface:

1、箭头图标是“元素选择”工具。单击一次以突出显示该图标。同时,鼠标在页面内的移动会同时选中HTML菜单中的相应内容。此时点击内容表示该元素被选中,图标高亮取消。如图(二):

萤火虫视图元素

2、控制面板

这里输出的是JS中console.log系列函数的打印

3、HTML

HTML 内容,注意这里看到的不一定是采集 想要解析的。对采集处内容的分析总是靠查看源码(Ctrl+U),这里只是可以快速定位的元素结构,然后选择一个比较特殊的引用,在源码中定位到对应的位置代码。

例如,如果您在 HTML 中看到一个标签

演示

,但是你查看源代码看到的可能是

演示

如果使用前者对采集内容进行正则匹配,则不会得到任何结果。

4、CSS

这里是CSS文件的内容

5、Script

这里是Javascript文件的内容

6、DOM

Dom 节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的。它可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求的内容保留在控制台中,如图(三):

此外,Firefox 还有一个 Tamper 数据扩展,也可以获取请求数据,需要时可以安装使用。

8、Cookies

Cookie 数据

图中(一),你也可以看到下面有很多可选的小菜单项,其中keep是我们要注意的。选择时,即使页面被刷新提交表单,下方内容区的数据仍会保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集请求的时候,主要关心的是“Network”菜单中的请求数据。如有必要,使用“Keep”查看刷新页面的请求数据。您可以在请求前使用“清除”清除以下内容。 .

案例分析

一、简的采集

这里简单的采集指的是采集单页GET请求。如此简单,即使通过file_get_contents函数也能轻松获取页面返回结果。

File_get_contents 代码片段

<p>

完整的采集神器(如何使用优采云采集进行搜索?写作推出智能采集工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-08-28 13:10

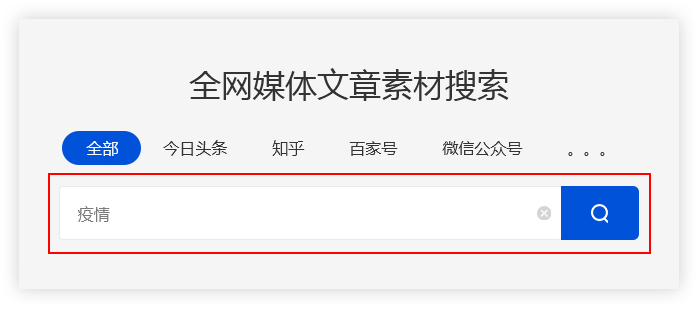

疫情期间,很多企业不得不选择远程在线办公。互联网是受疫情影响较小的行业之一。然而,远程办公仍然没有面对面工作那么高效。出于这个原因优采云采集专利权采集tools。

相信很多运营商都接触过采集tools。现在市场上有很多种采集tools。很多人认为采集工具只是文章hot/festival 话题等信息采集 的辅助工具,其实不仅如此。一个成熟的采集工具,不仅是帮助运营采集信息,更要精准分析数据趋势,帮助增加收益。

一、什么是优采云采集?

优采云采集是自媒体材料搜、文章原创的运营工具,一键发布,有效提高新媒体运营效率,降低企业成本。

二、如何使用优采云采集进行搜索?

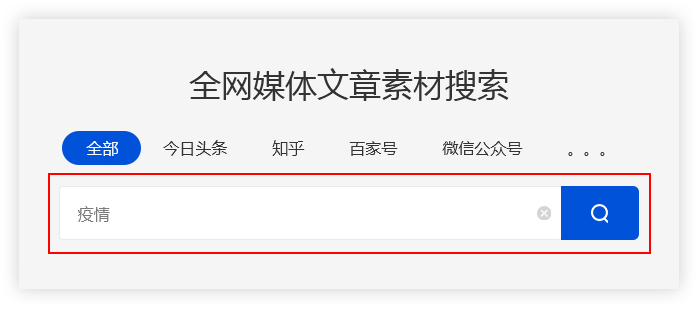

(一)输入关键词

优采云采集 根据用户输入的关键词,搜索引擎通过程序自动进入主流自媒体数据源。

优采云采集基于高级算法匹配更准确的内容,提高搜索内容的准确性。

例如:

用户需要采集与疫情相关的资料,在主页输入关键词“流行病”。 优采云采集 会将搜索结果整合到一个列表中。

(二)保存搜索资料

优采云采集具有批量保存搜索资料的功能。

点击【全选当前页】功能,勾选需要的文章,文章会添加到操作面板中,方便用户批量保存。

(三)精准过滤

1、搜索过滤器

优采云采集支持根据标题、内容、时间、平台、是否原创等参数进行过滤,使搜索内容更加准确。

2、广告过滤 查看全部

完整的采集神器(如何使用优采云采集进行搜索?写作推出智能采集工具)

疫情期间,很多企业不得不选择远程在线办公。互联网是受疫情影响较小的行业之一。然而,远程办公仍然没有面对面工作那么高效。出于这个原因优采云采集专利权采集tools。

相信很多运营商都接触过采集tools。现在市场上有很多种采集tools。很多人认为采集工具只是文章hot/festival 话题等信息采集 的辅助工具,其实不仅如此。一个成熟的采集工具,不仅是帮助运营采集信息,更要精准分析数据趋势,帮助增加收益。

一、什么是优采云采集?

优采云采集是自媒体材料搜、文章原创的运营工具,一键发布,有效提高新媒体运营效率,降低企业成本。

二、如何使用优采云采集进行搜索?

(一)输入关键词

优采云采集 根据用户输入的关键词,搜索引擎通过程序自动进入主流自媒体数据源。

优采云采集基于高级算法匹配更准确的内容,提高搜索内容的准确性。

例如:

用户需要采集与疫情相关的资料,在主页输入关键词“流行病”。 优采云采集 会将搜索结果整合到一个列表中。

(二)保存搜索资料

优采云采集具有批量保存搜索资料的功能。

点击【全选当前页】功能,勾选需要的文章,文章会添加到操作面板中,方便用户批量保存。

(三)精准过滤

1、搜索过滤器

优采云采集支持根据标题、内容、时间、平台、是否原创等参数进行过滤,使搜索内容更加准确。

2、广告过滤

完整的采集神器(本文介绍如何采集网站上多关键词的流程图模式?介绍 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 184 次浏览 • 2021-08-28 10:11

)

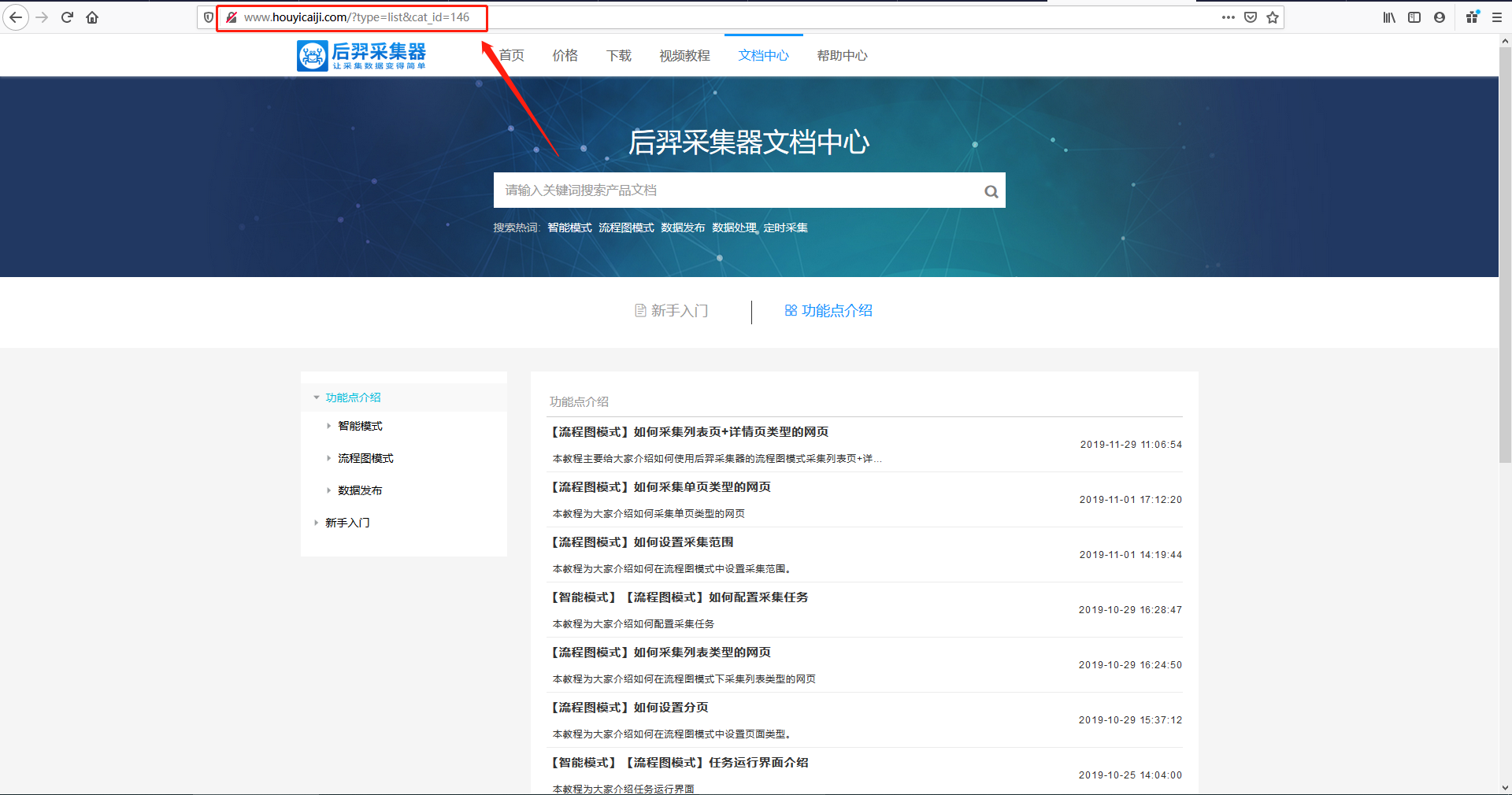

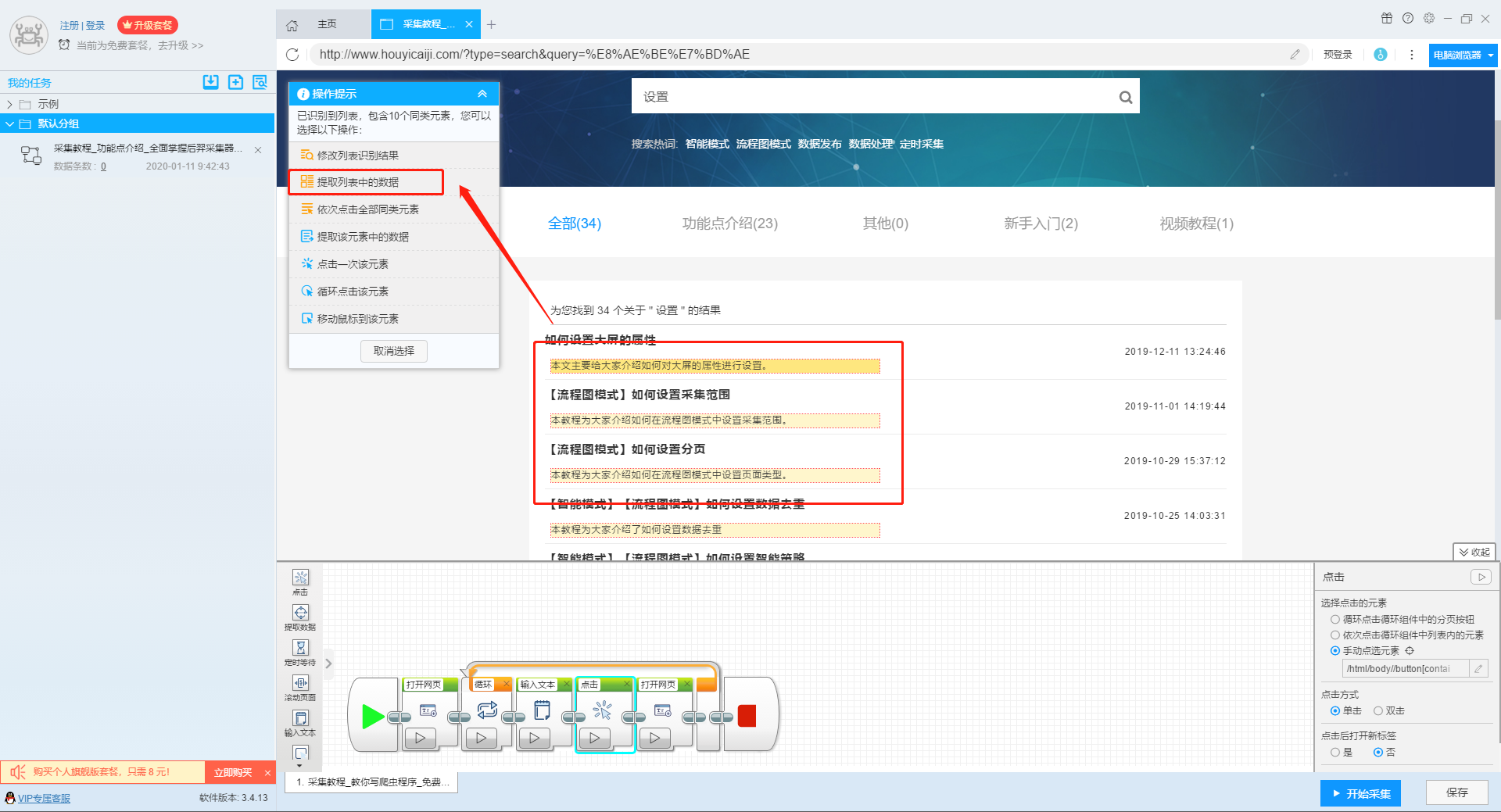

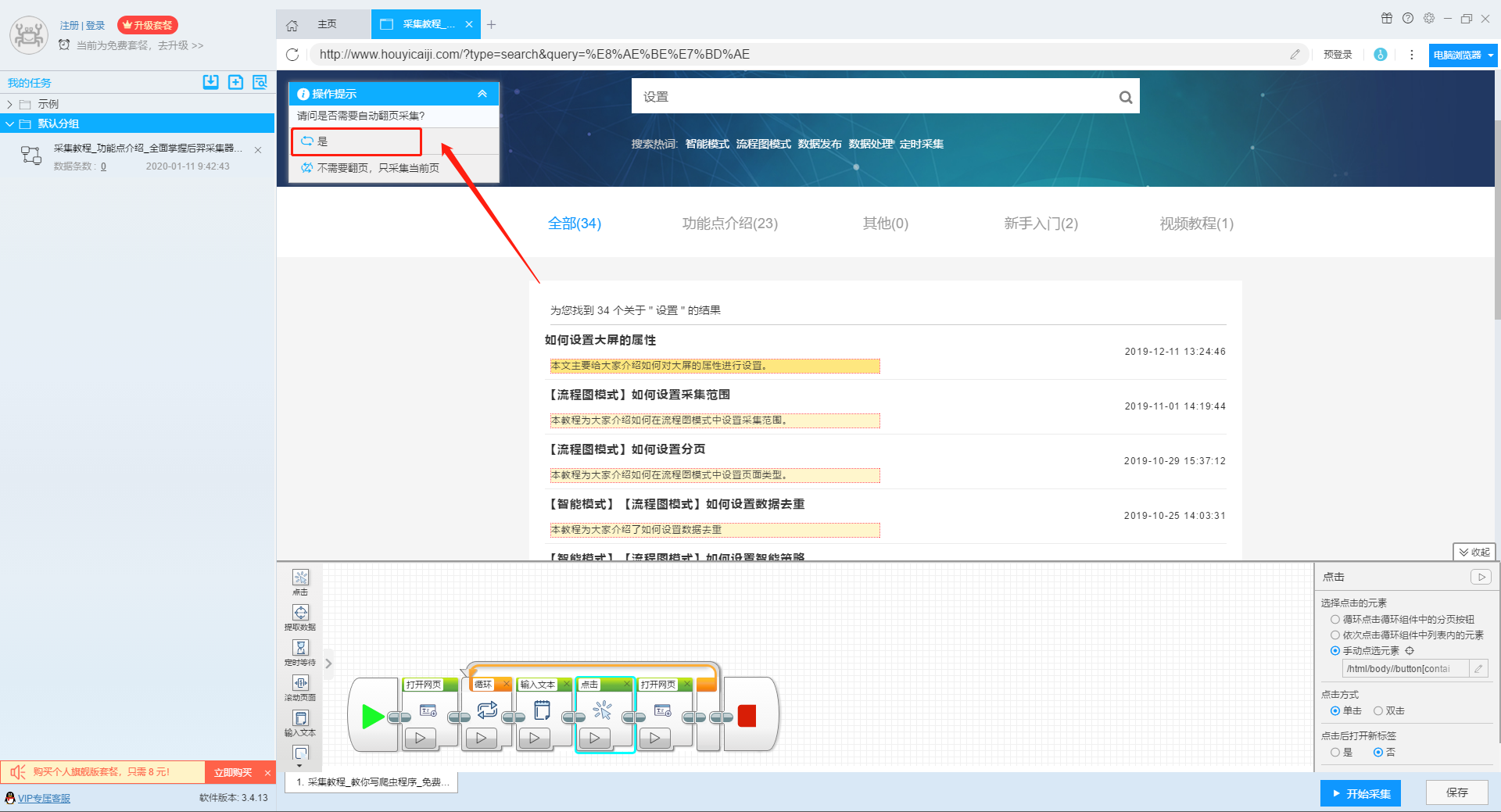

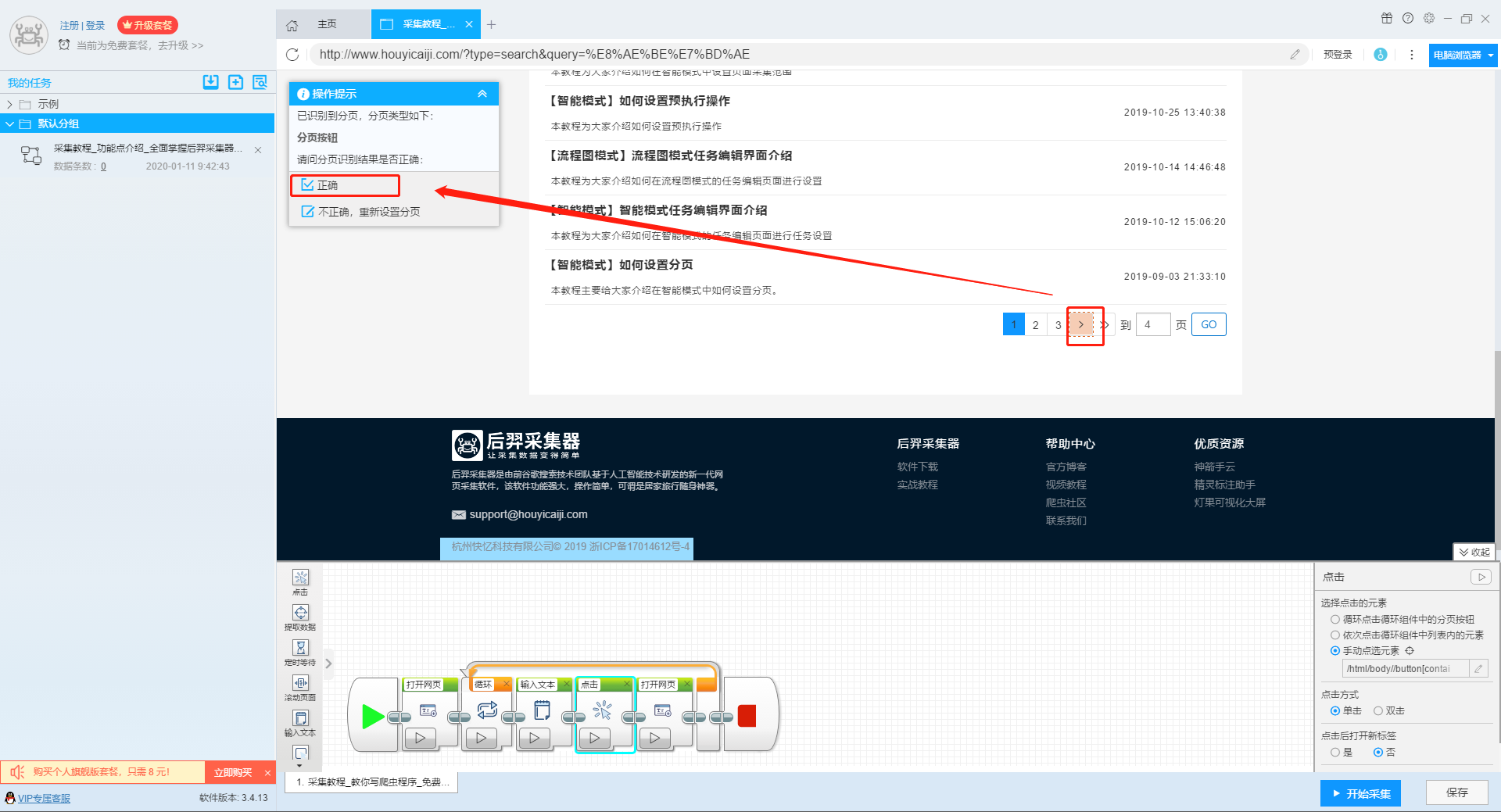

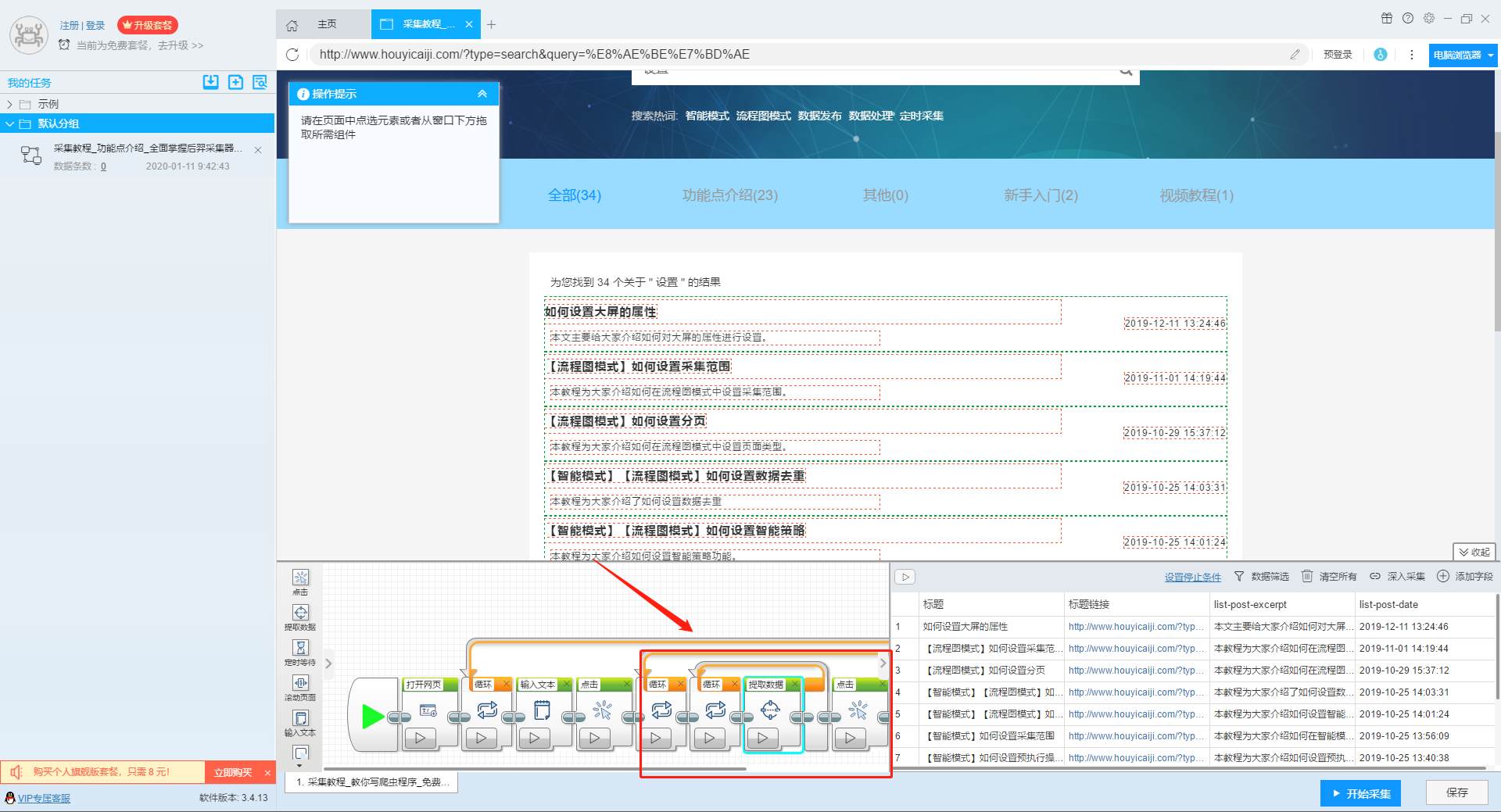

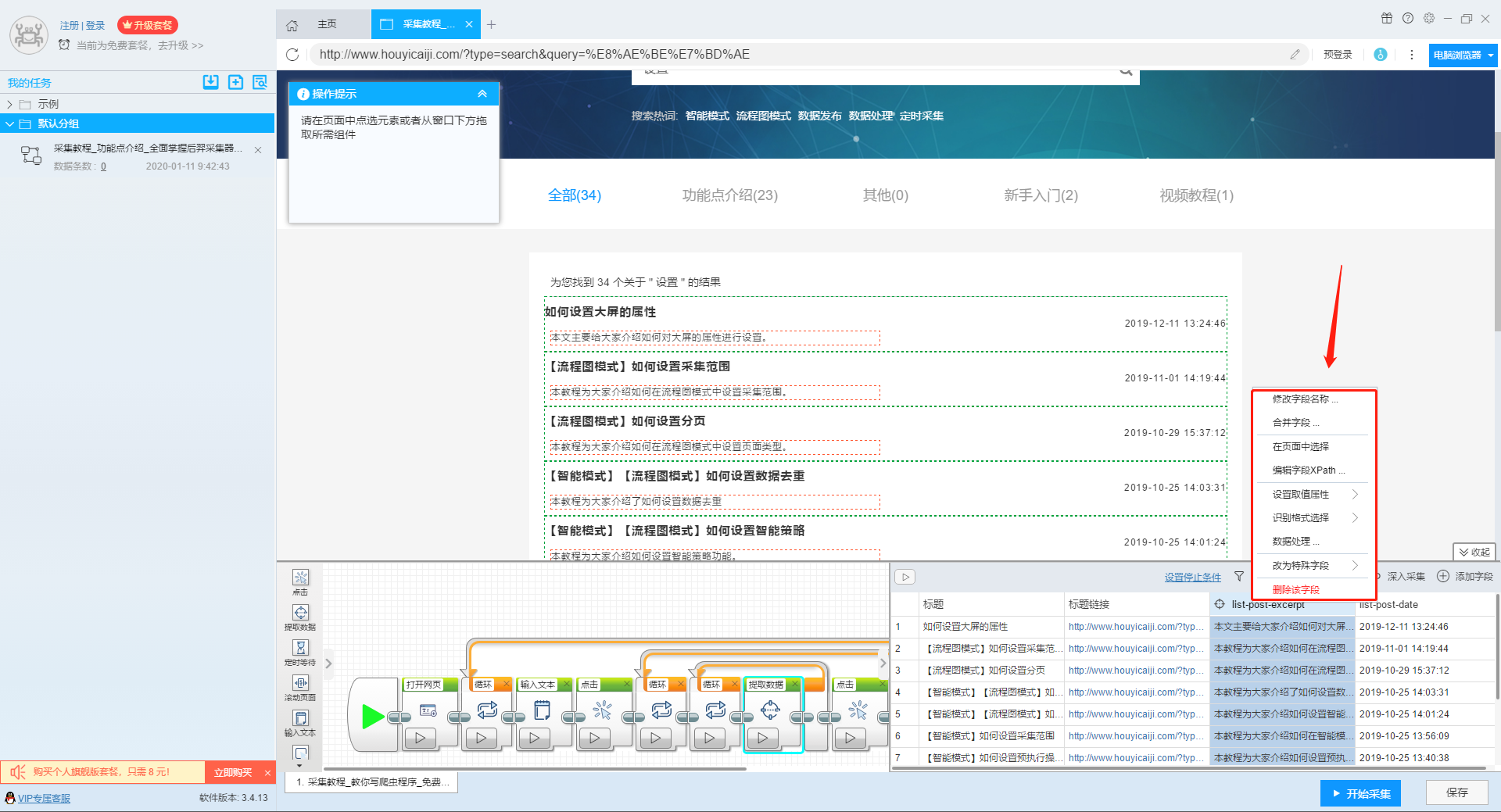

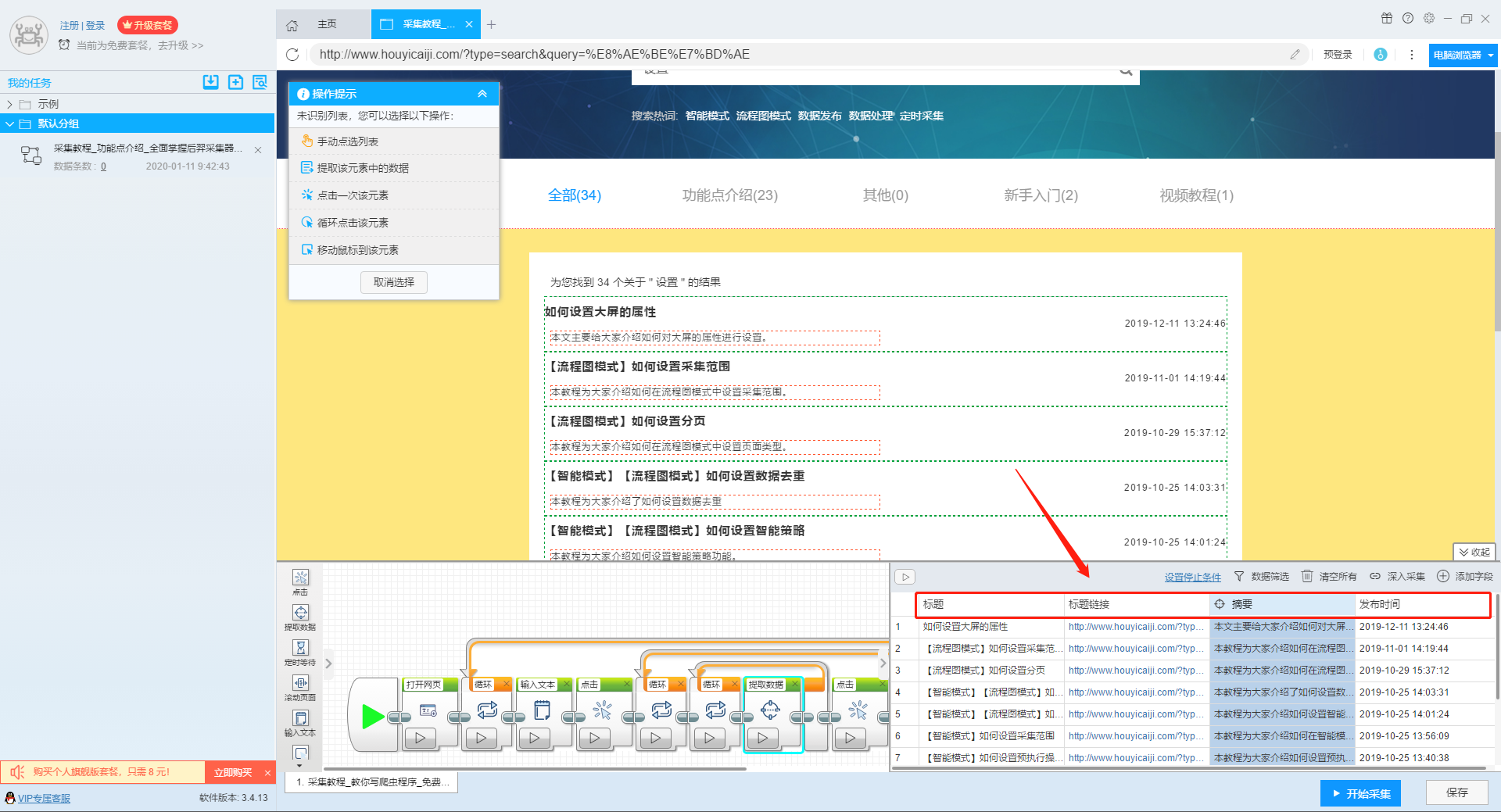

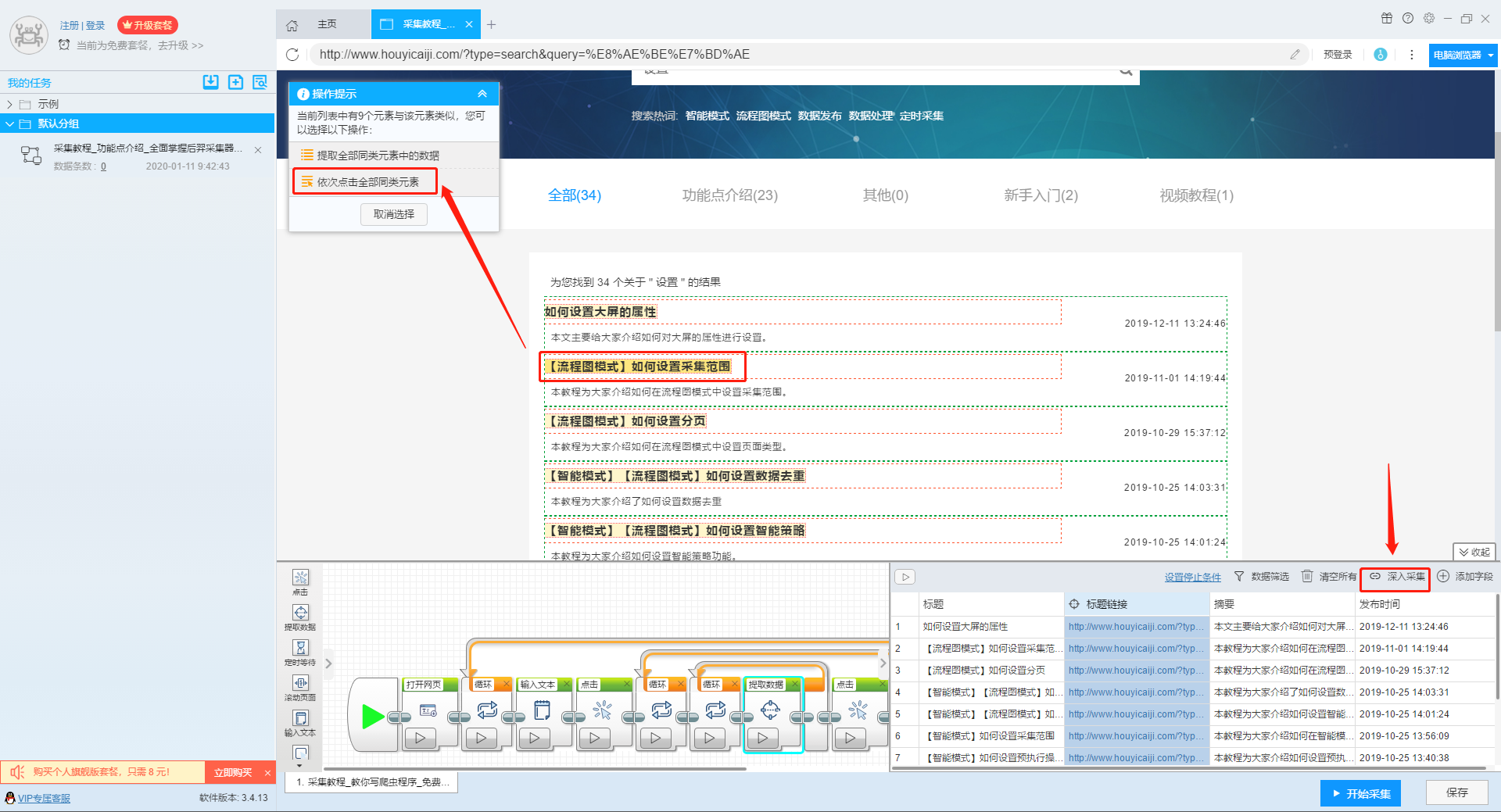

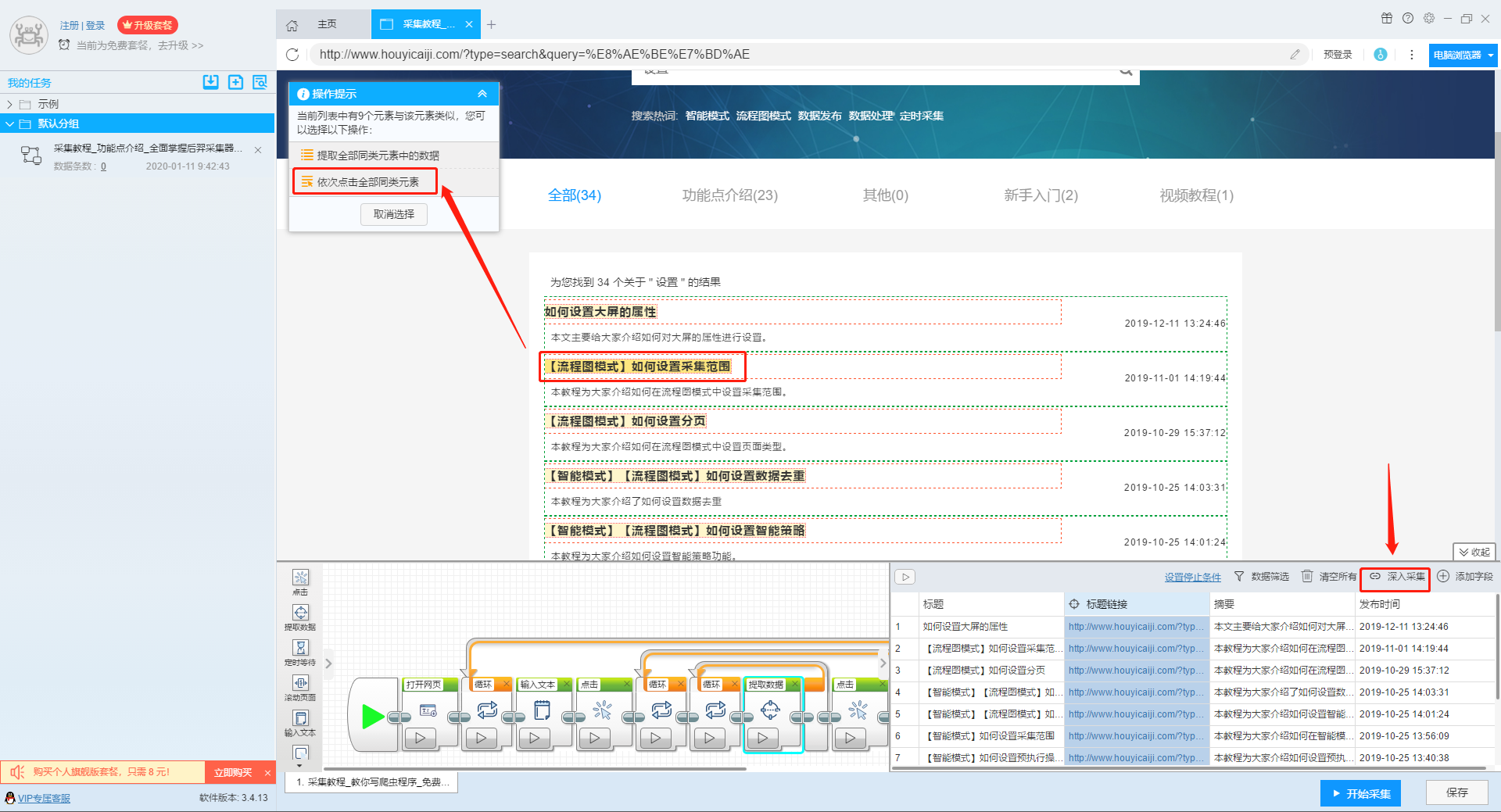

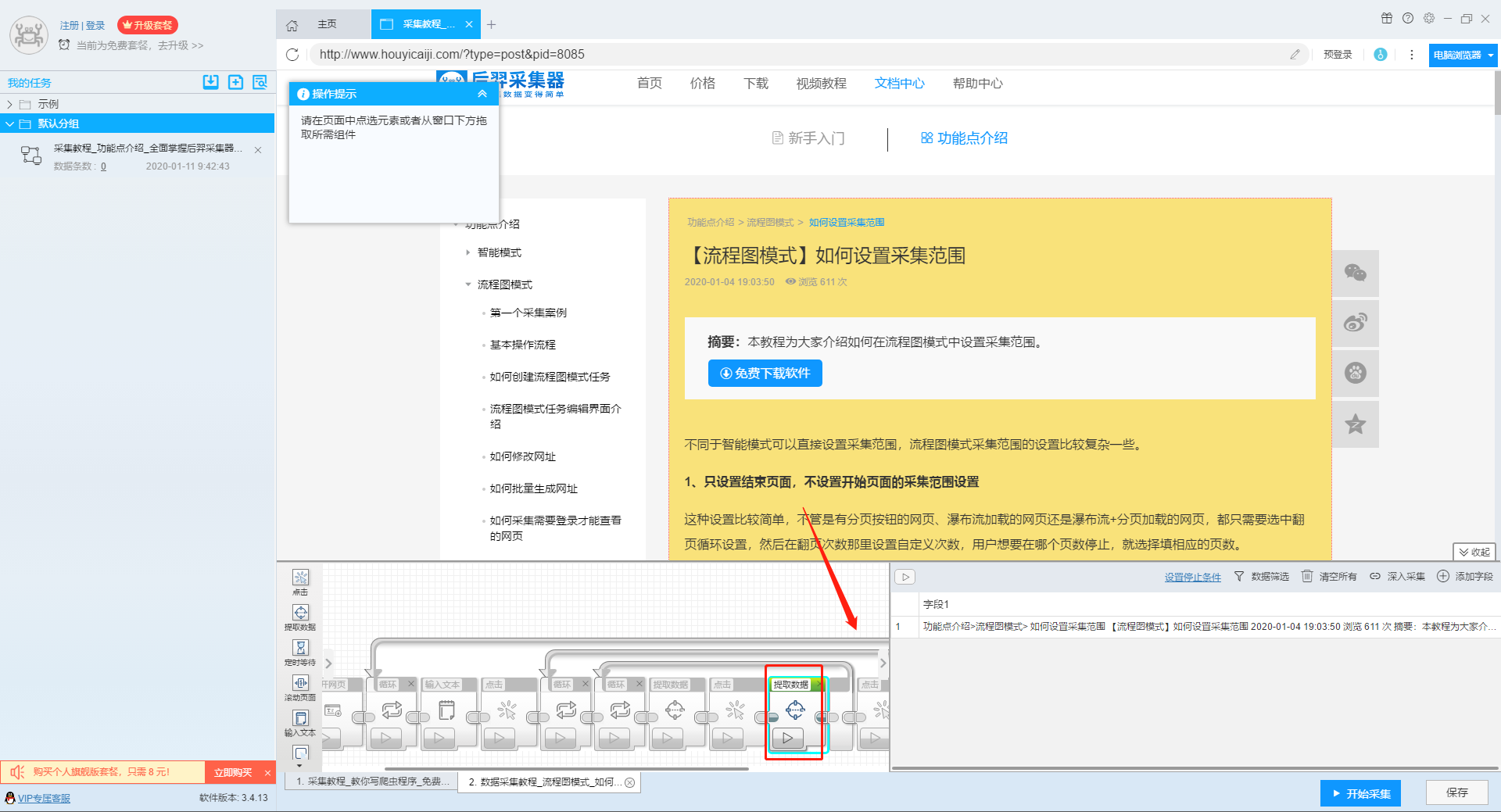

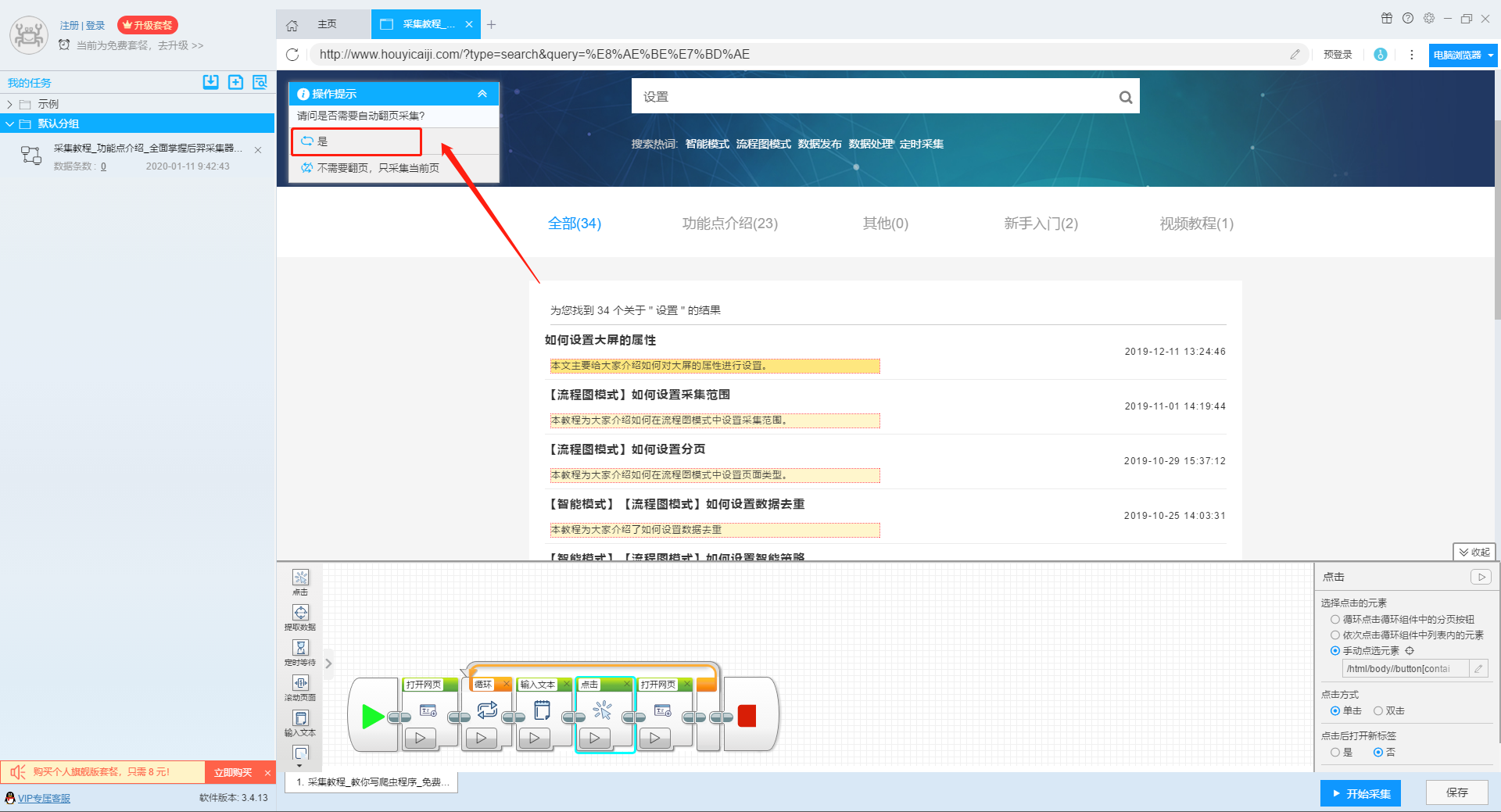

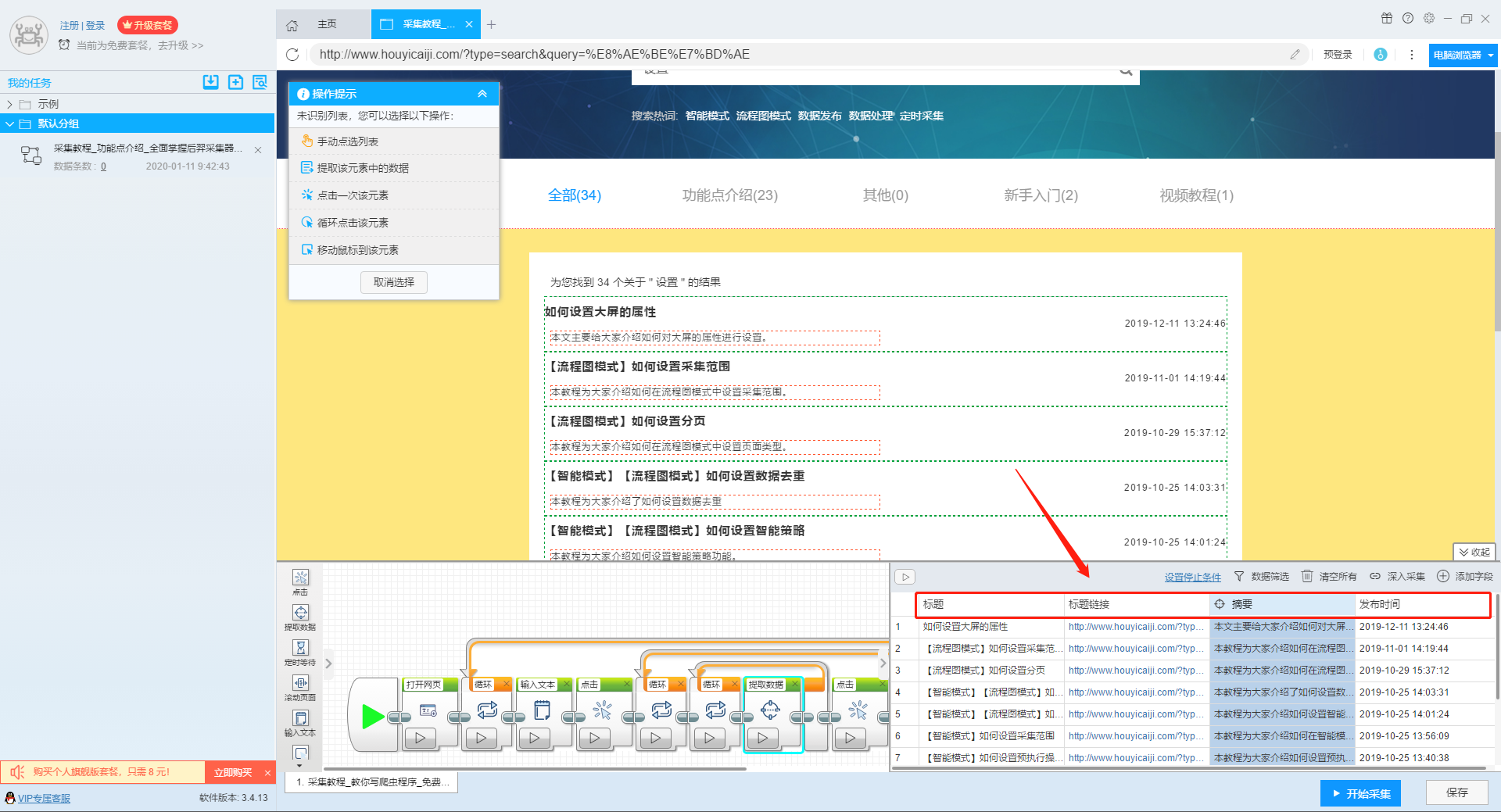

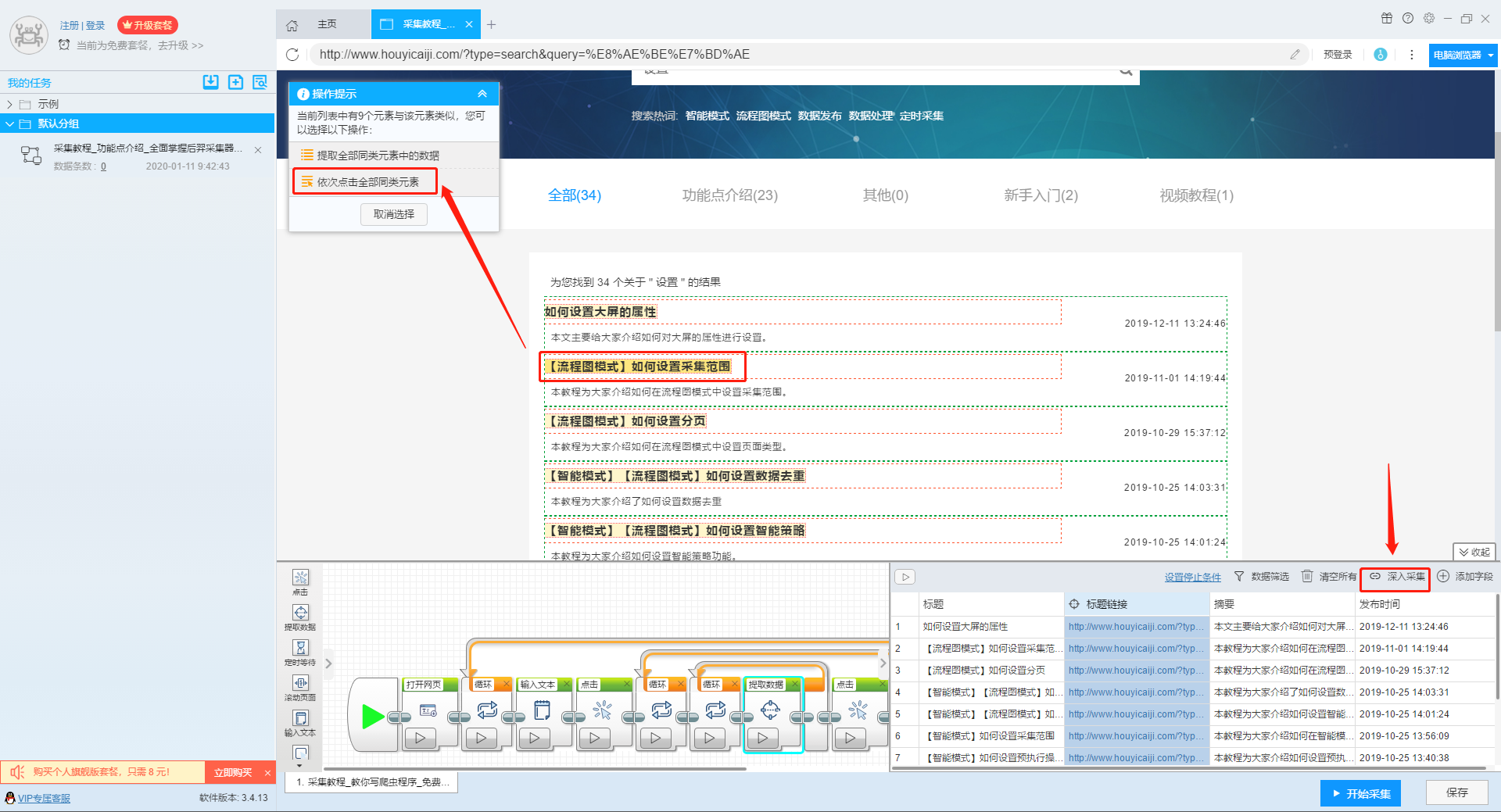

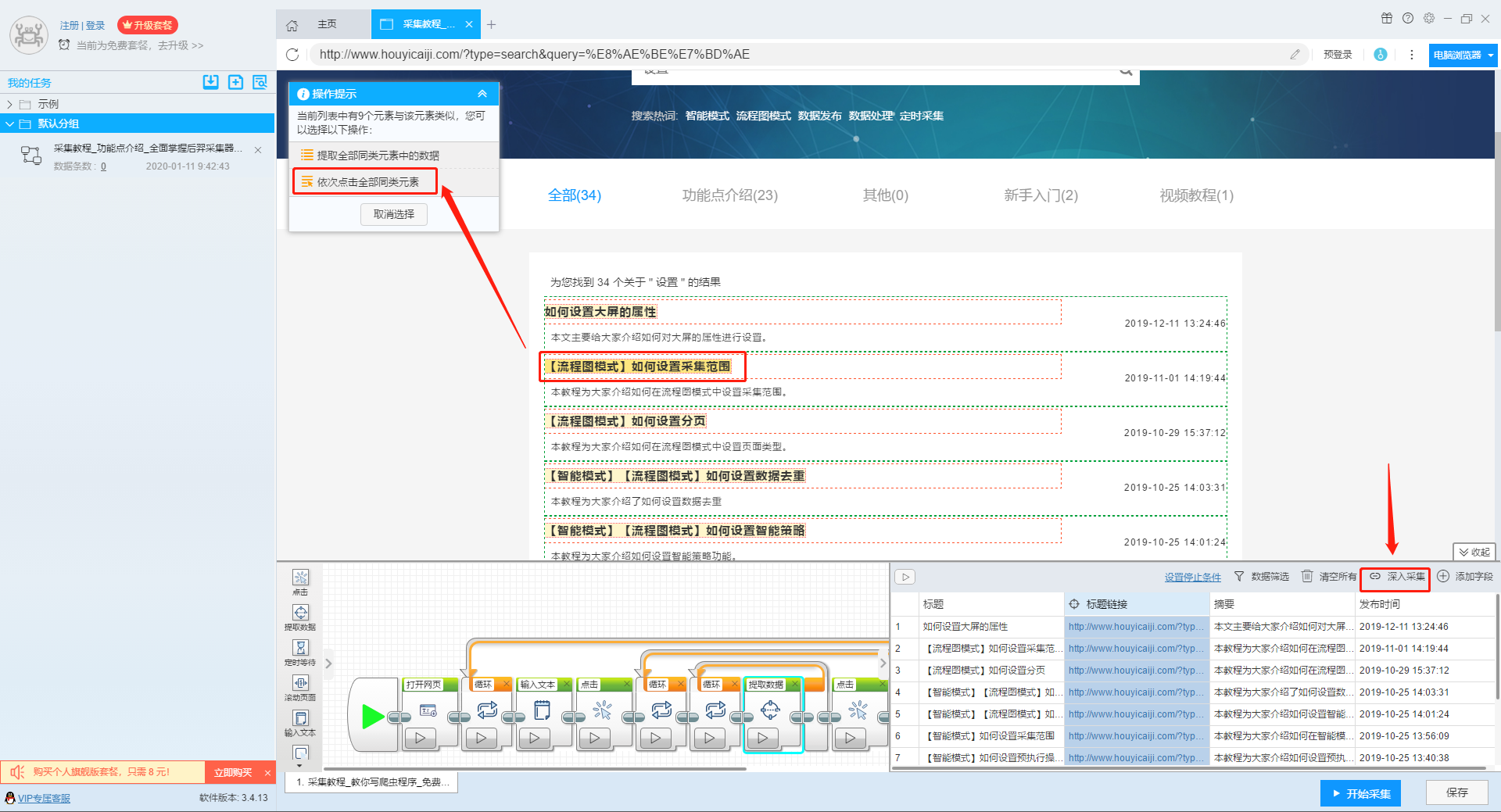

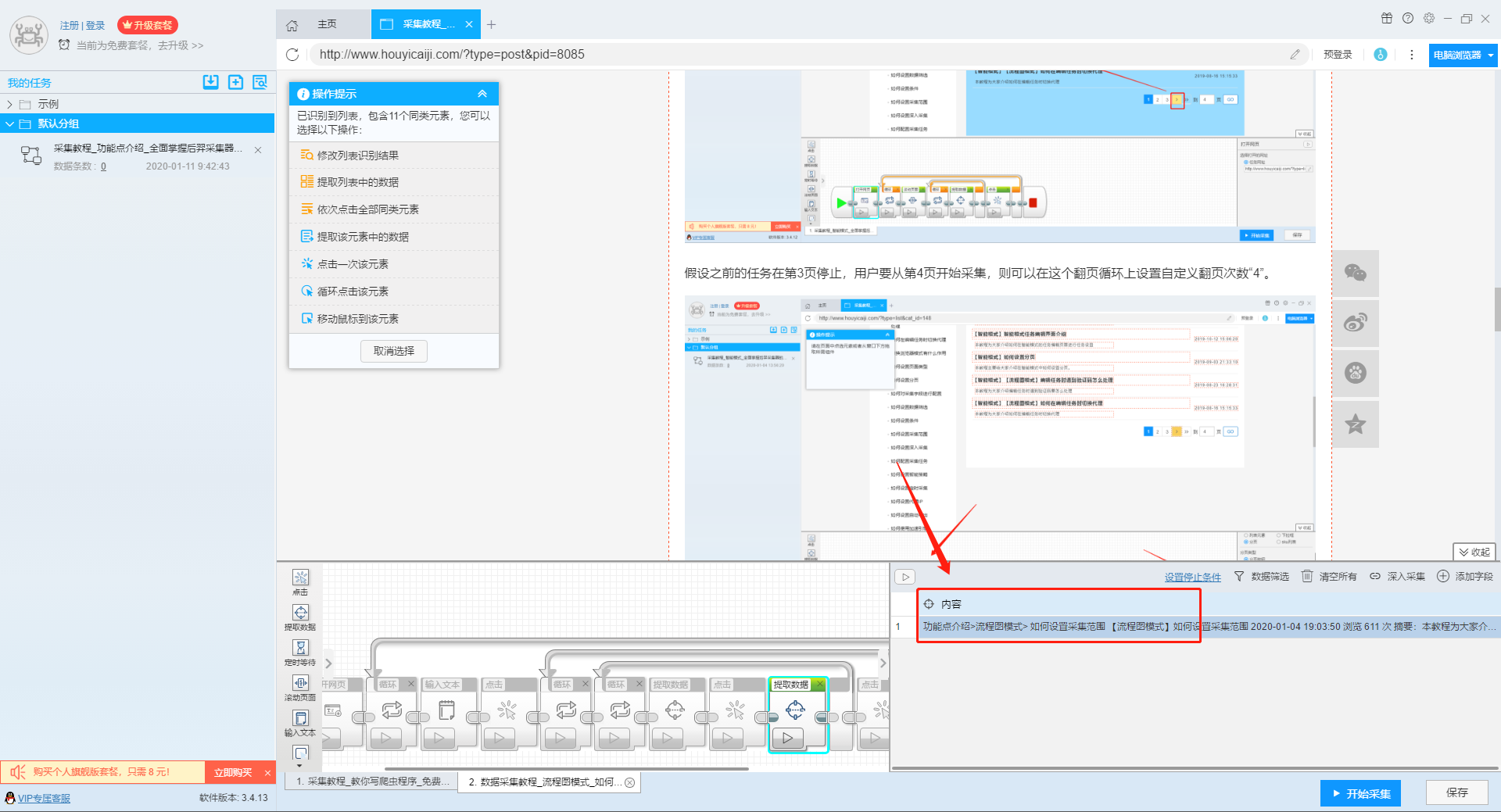

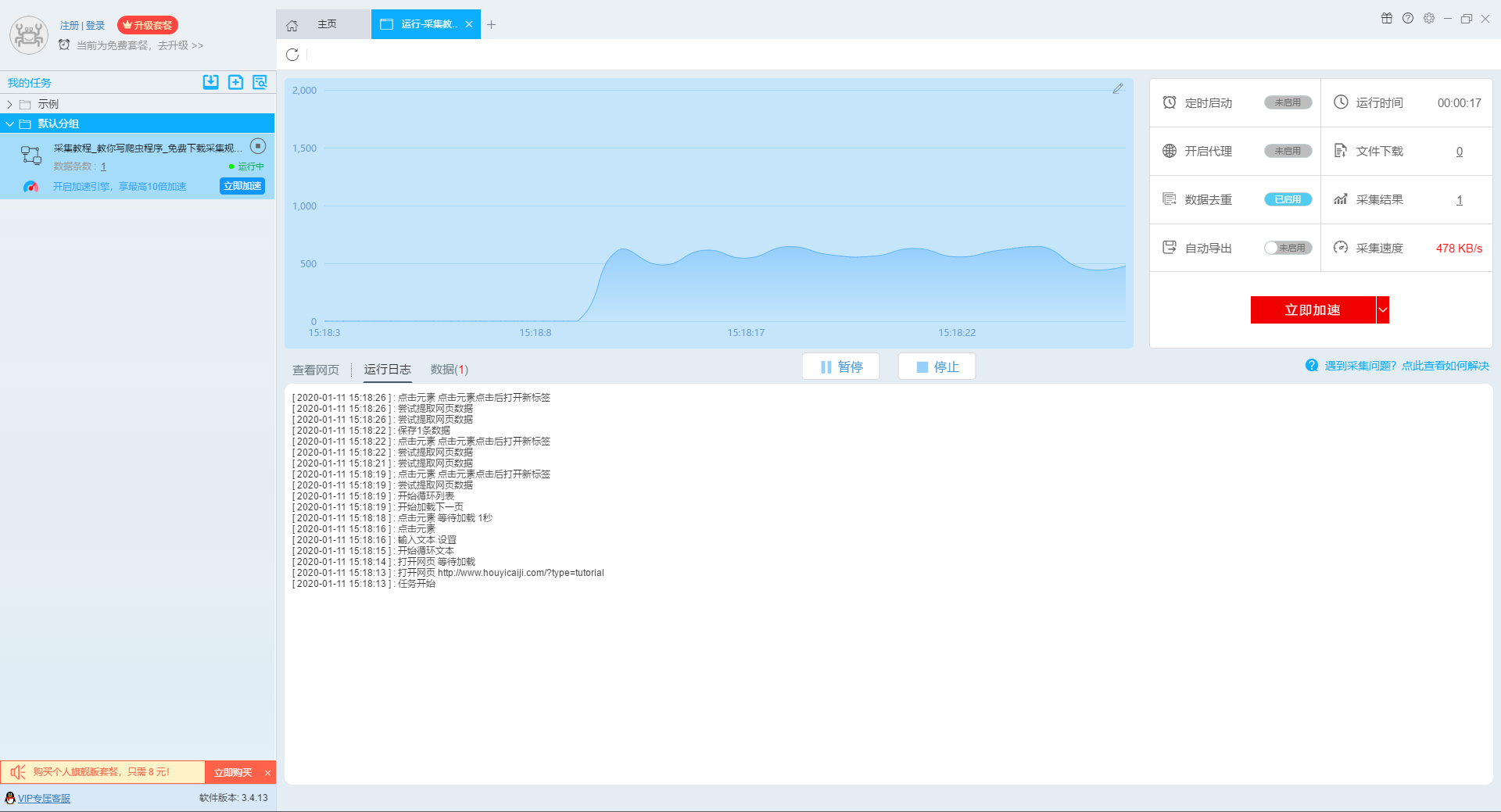

本文介绍如何使用优采云采集器的流程图模式,并介绍如何采集网站上多关键词。

第一步:新建采集task

1、复制官网网址(需要搜索结果页面的网址,不是首页的网址)

点击此处了解如何正确输入网址。

2、新流程图模式采集task

可以直接在软件上创建采集任务,也可以通过导入规则来创建任务。

单击此处了解如何导入和导出采集 规则。

第二步:配置采集规则

1、设置多个关键字循环任务

流程图模式下输入创建新任务的URL后,我们点击搜索框,然后在左上角出现的操作提示框中输入采集的文字。

单击此处了解有关输入文本组件的更多信息。

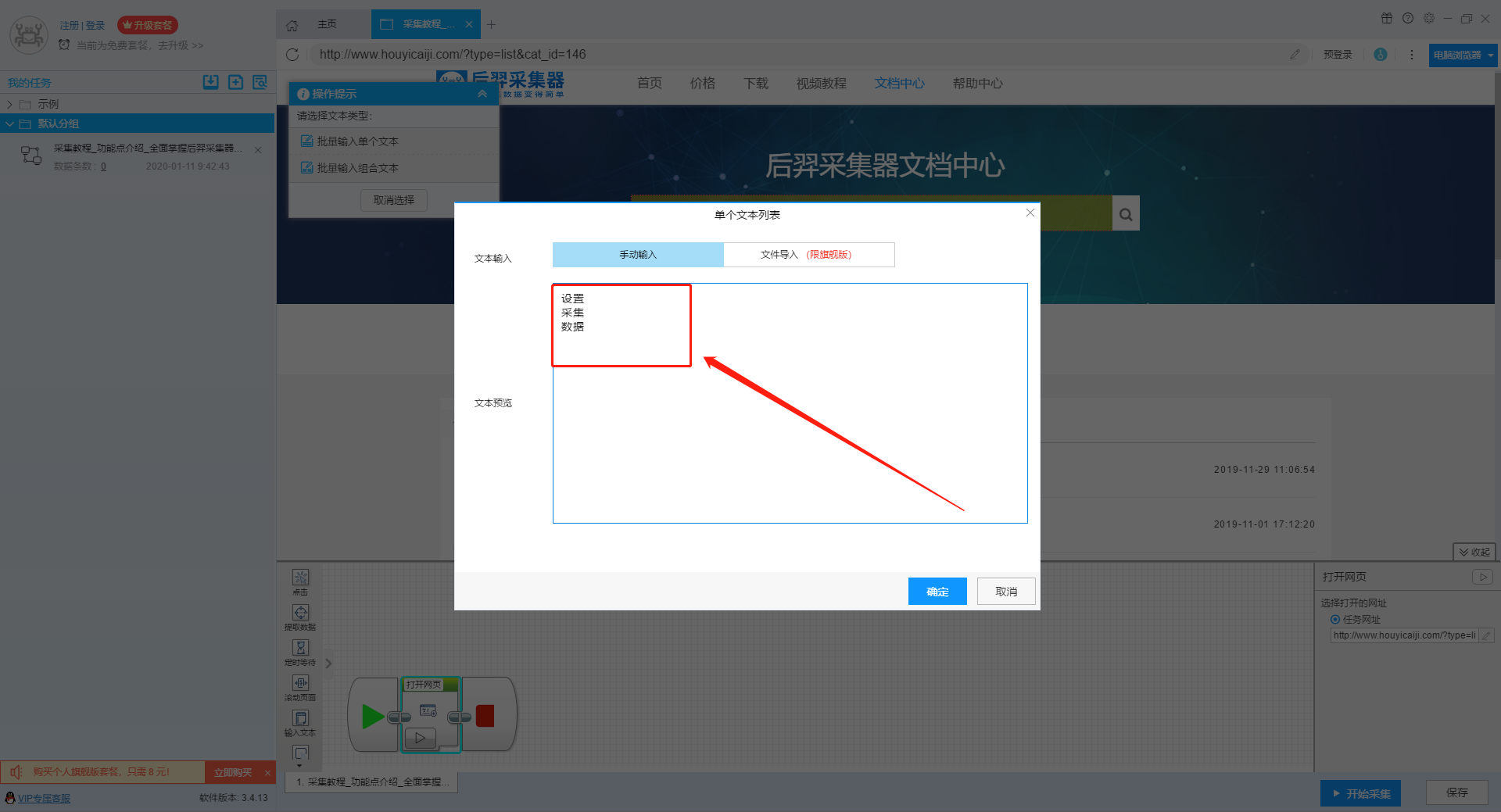

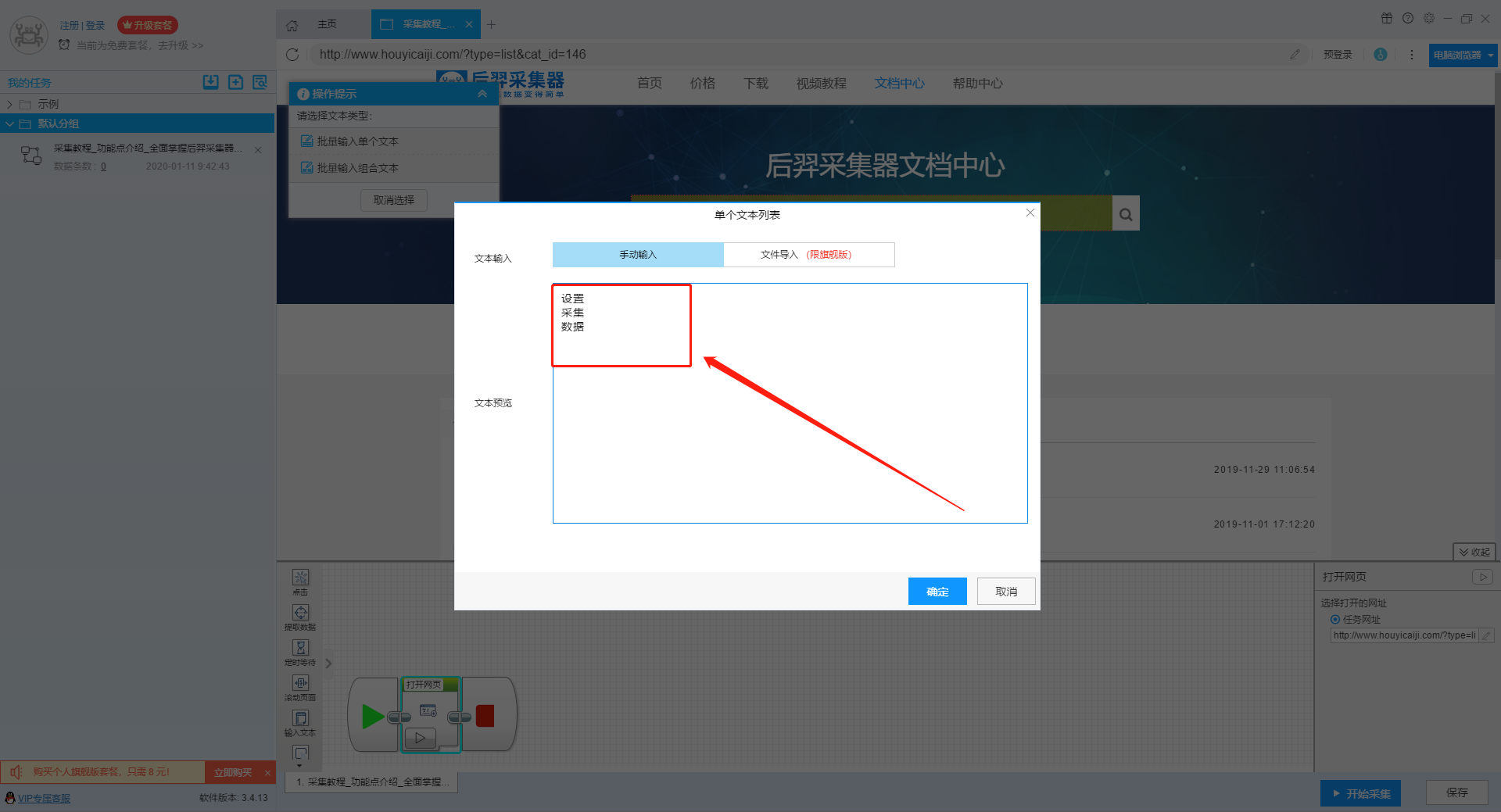

由于需要输入多个关键词数据,我们选择点击操作框上的批量输入文本按钮。

然后选择批量输入单个文本。

然后在弹出的文本列表中输入我们需要设置的文本,这里我们输入“设置”、“采集”、“数据”关键词。

点击“确定”按钮后,软件会自动生成一个圆形的关键词列表。

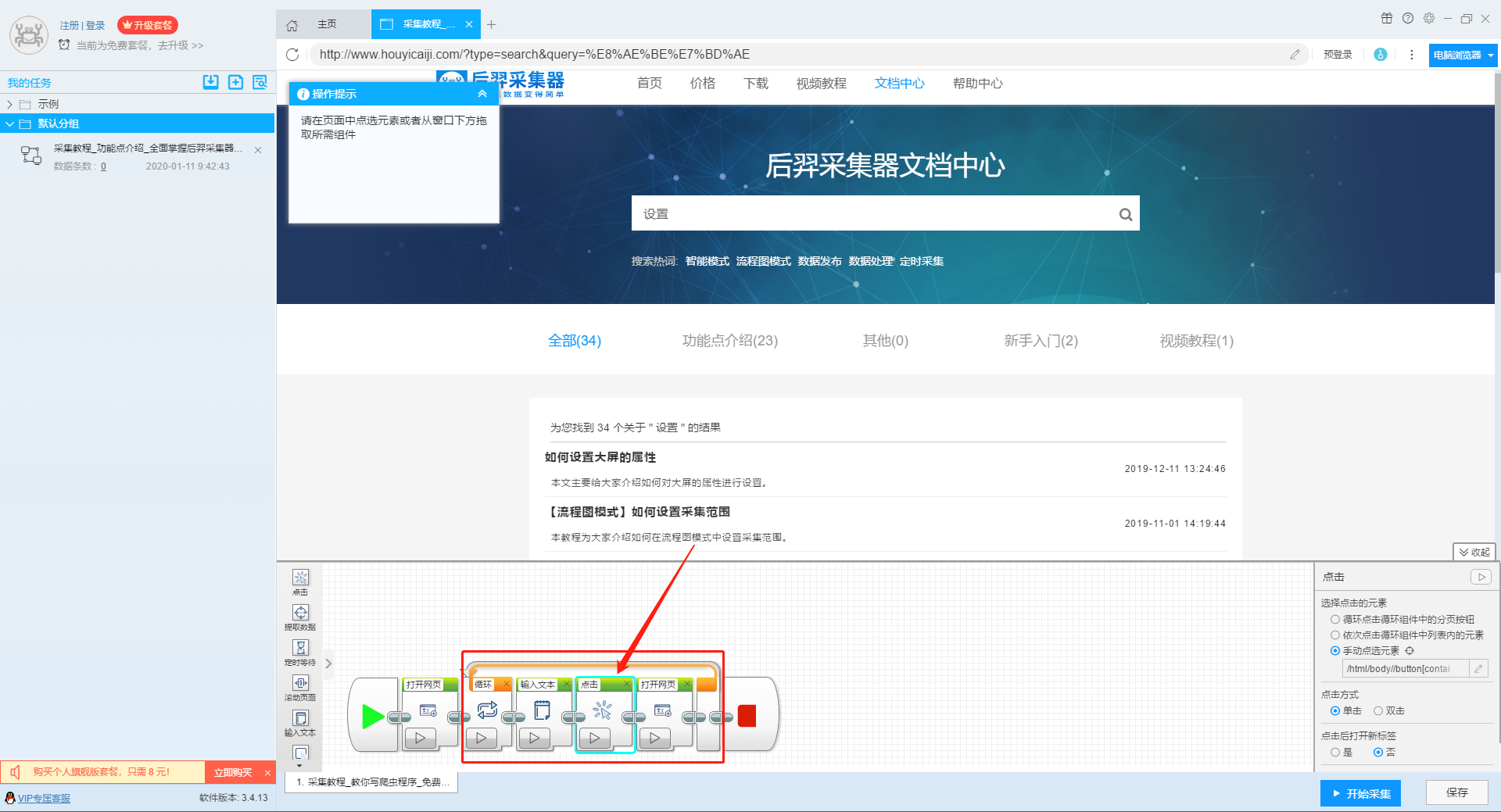

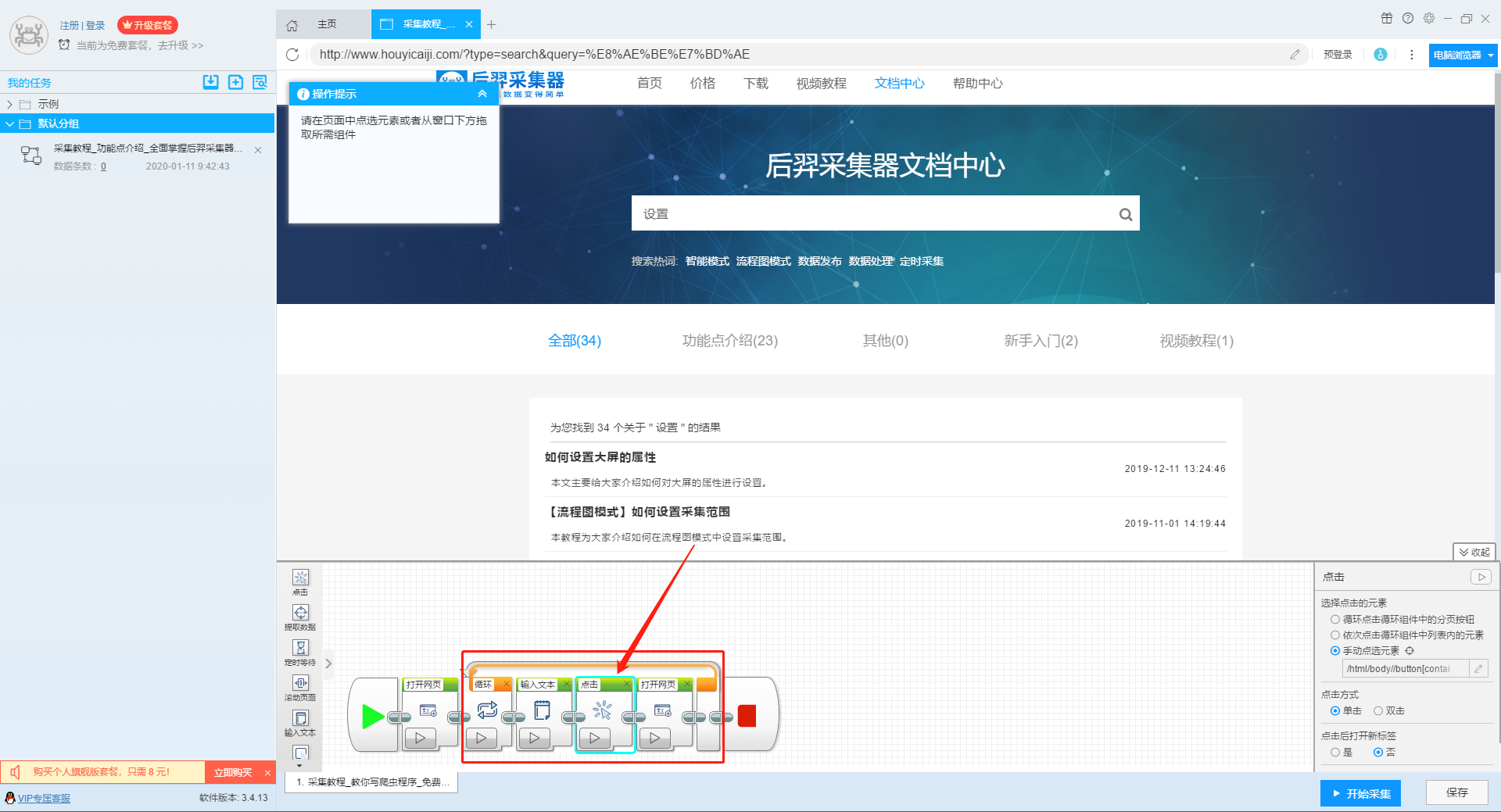

然后我们点击页面上的搜索按钮,在操作框中选择“点击该元素一次”按钮,跳转到搜索结果页面。

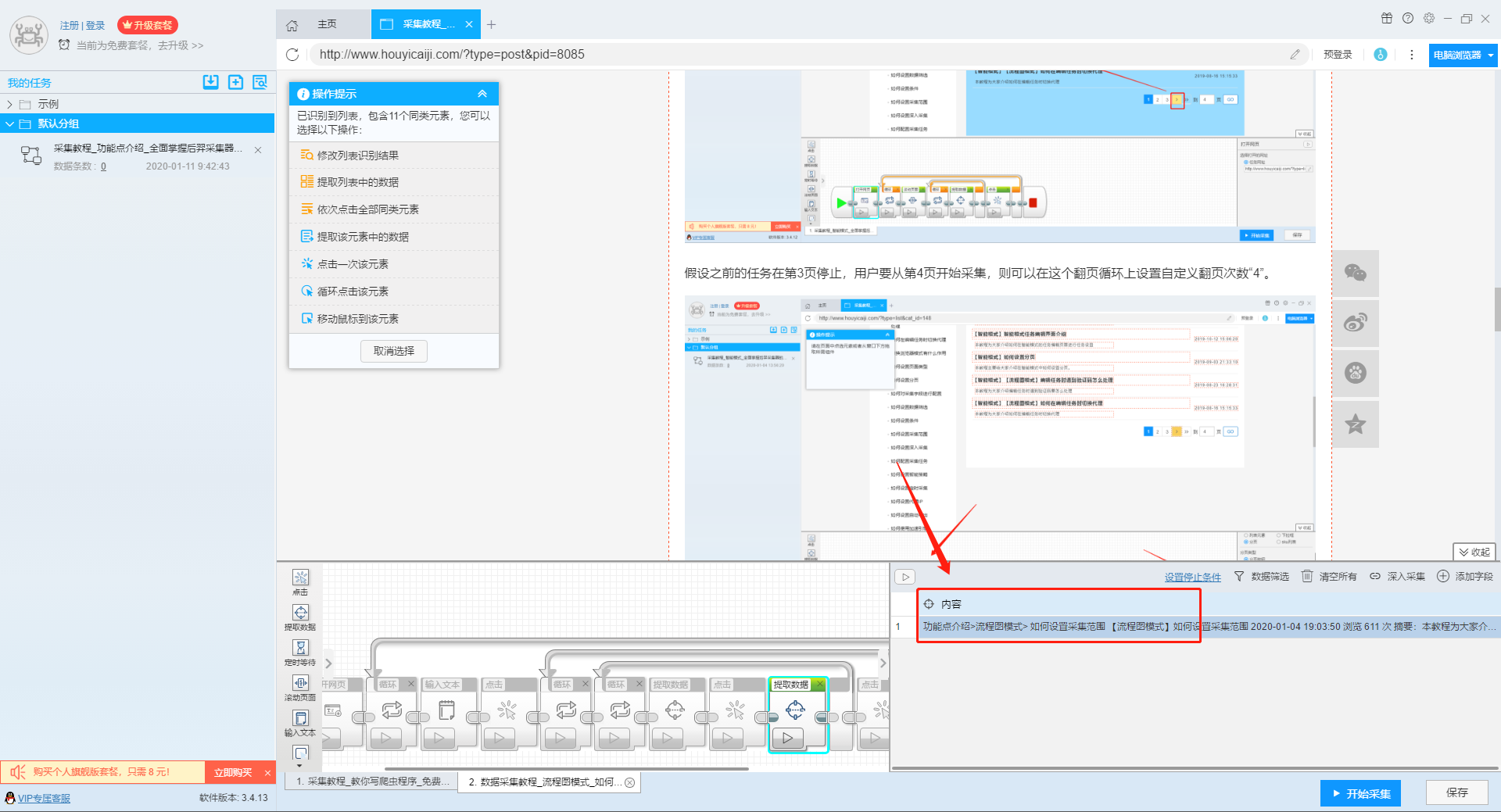

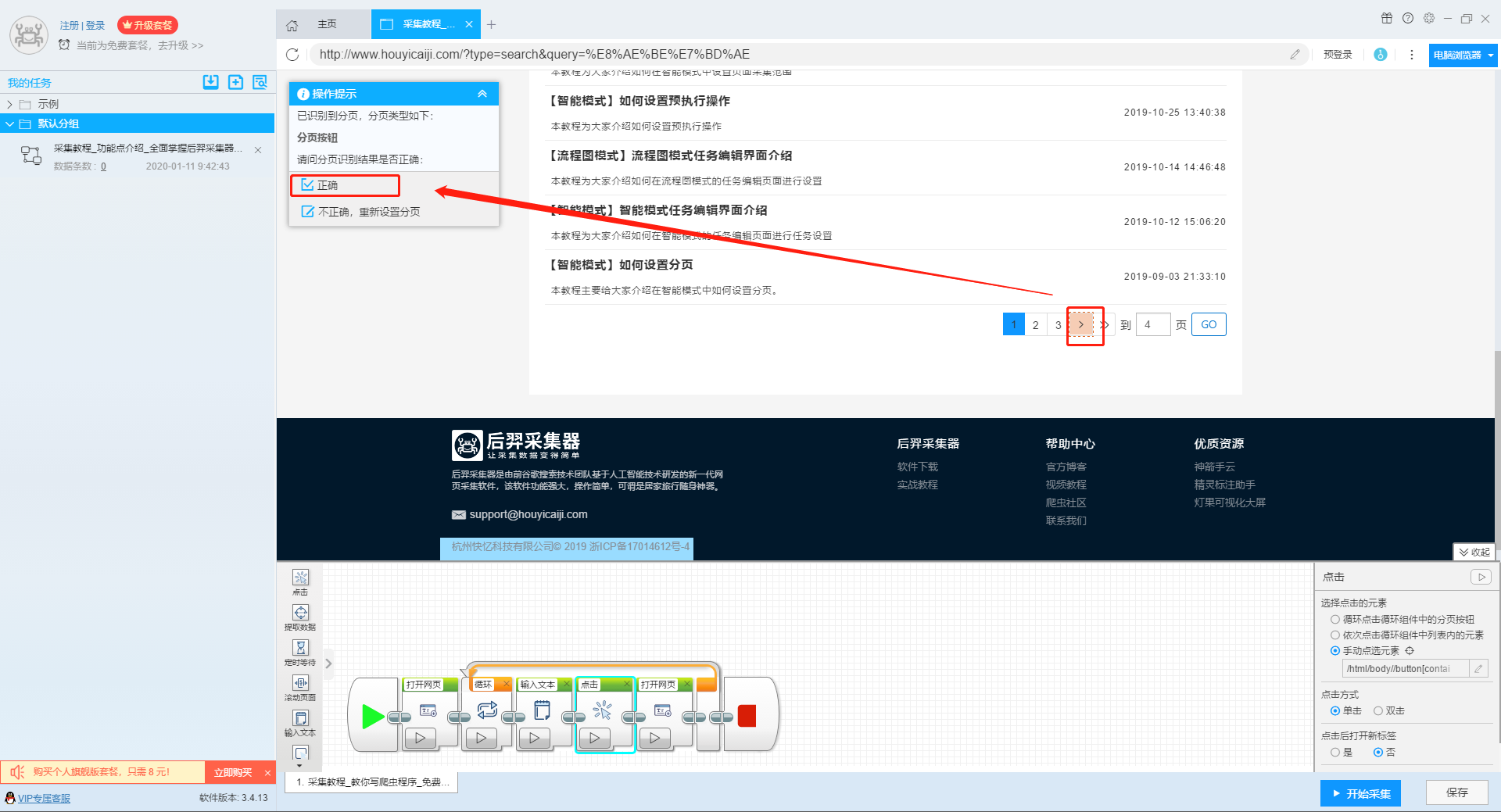

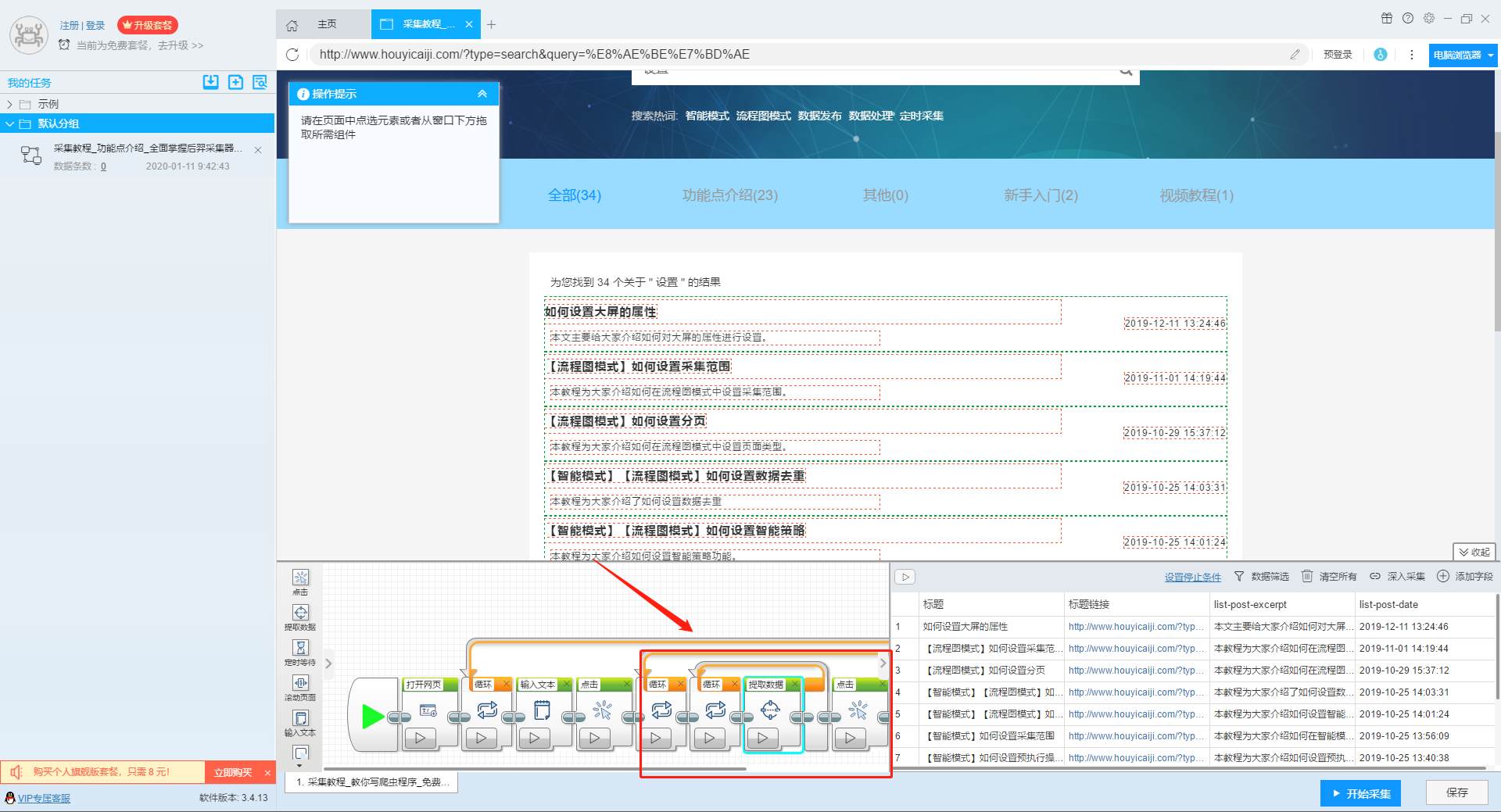

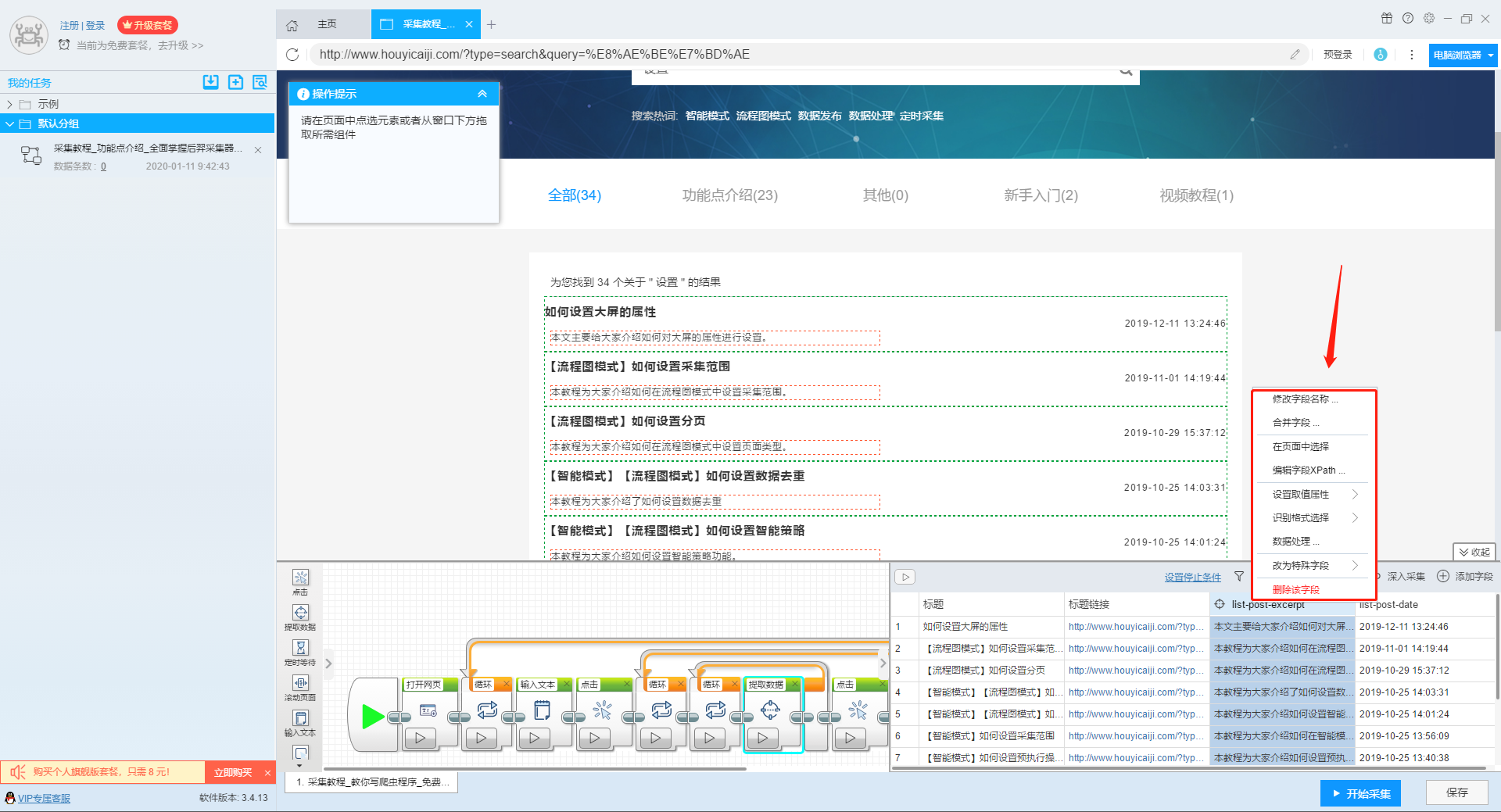

2、设置提取字段数据

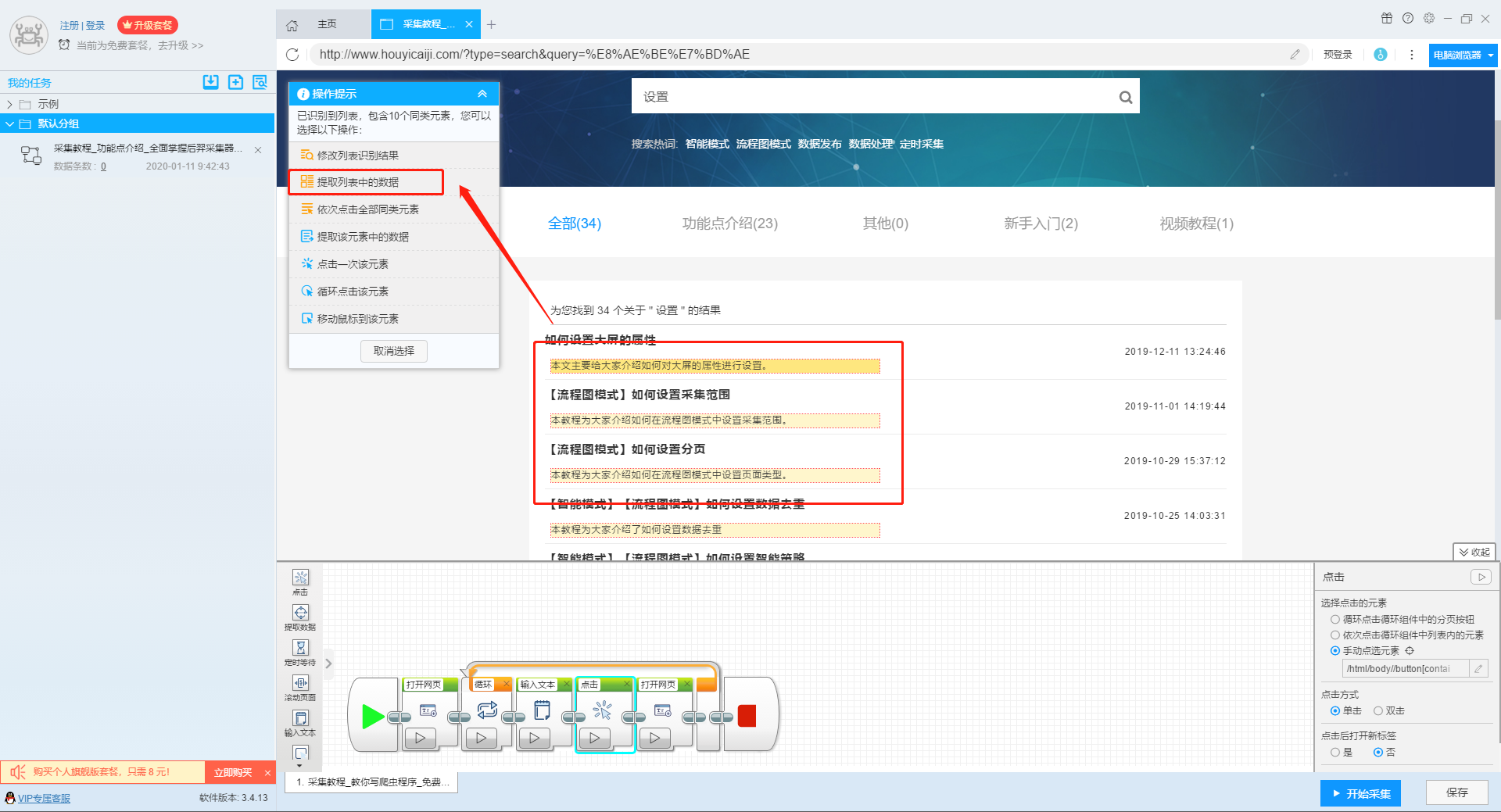

输入多个关键字并设置循环后,我们设置需要提取的字段数据,点击网页上的字段,在左上角的操作提示框中选择提取所有元素。然后软件会自动识别分页,用户根据软件提示设置分页。

然后我们可以在此基础上设置采集字段,用户可以根据自己的需要进行设置。

更多详情,请参考以下教程:

如何配置采集字段

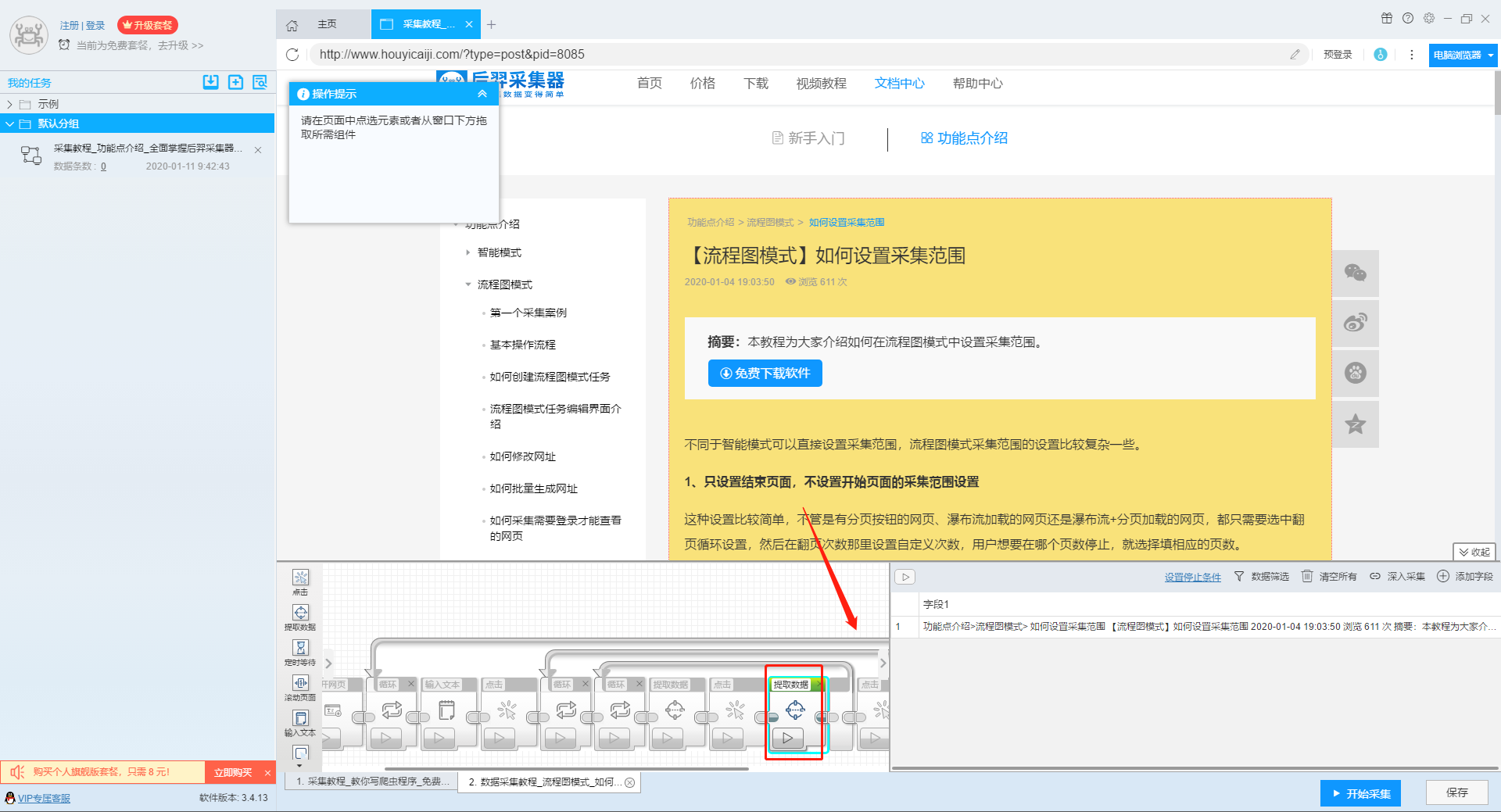

3、深入设置采集

如果需要采集detail页面的数据,可以使用deep采集函数。

更多详情,请参考以下教程:

如何实现深入采集

4、设置详情页数据

详情页的采集与单页类型的采集相同。我们点击页面上需要采集的数据,然后点击操作提示框中的“从此元素中提取数据”按钮,数据设置可以参考列表页上的设置。

更多详情,请参考以下教程:

如何采集单页类型网页

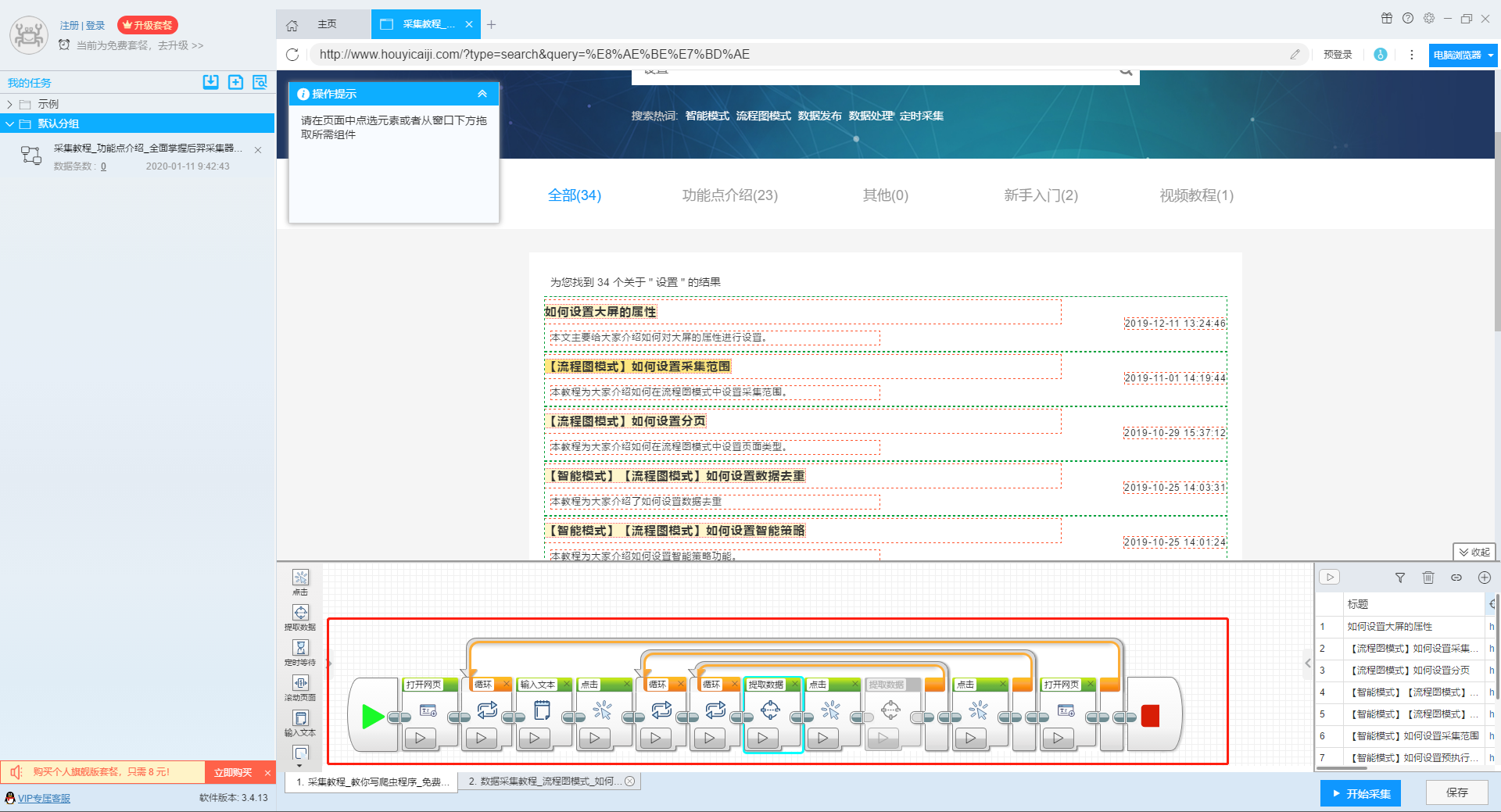

5、完整的组件图

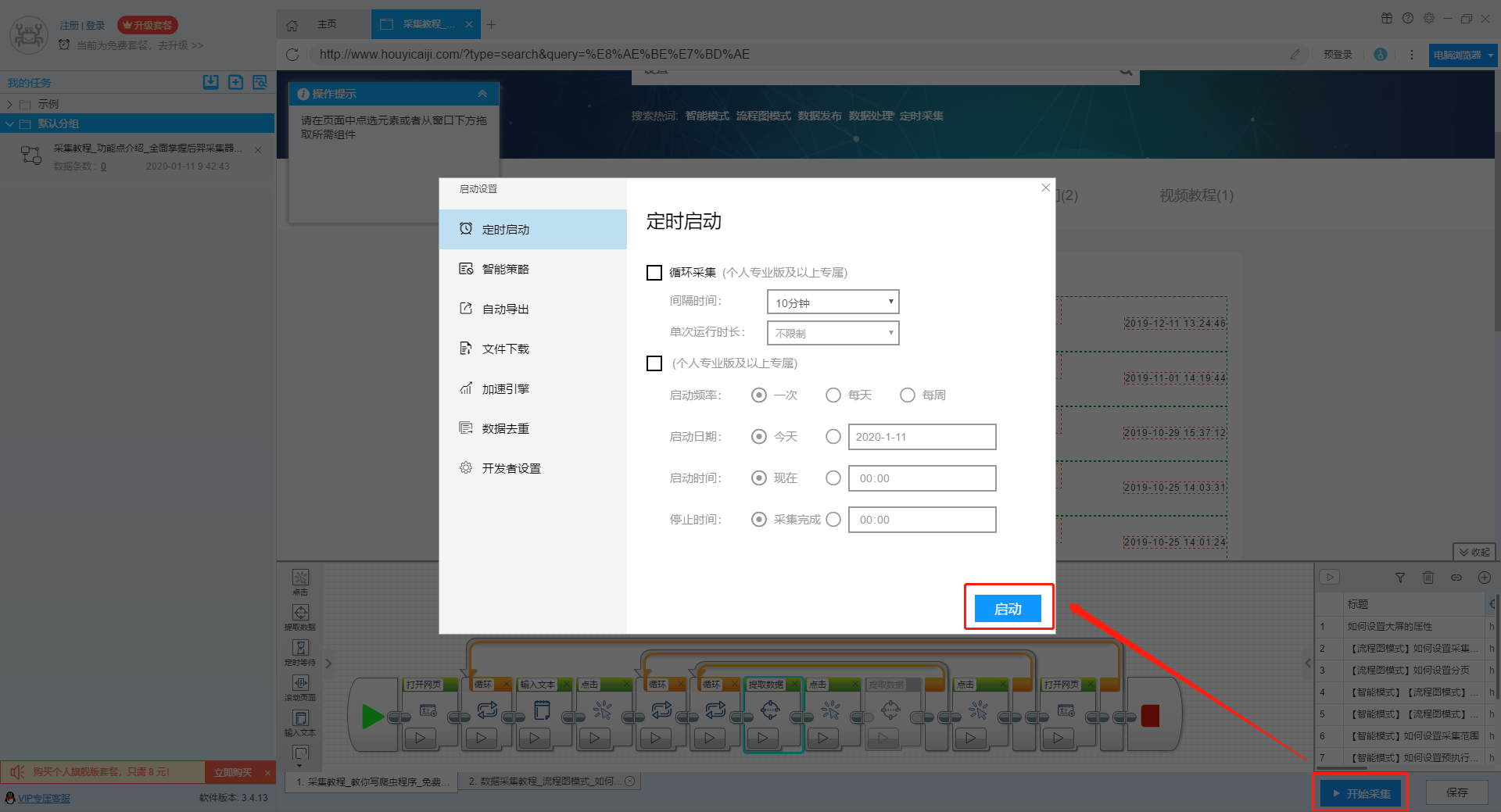

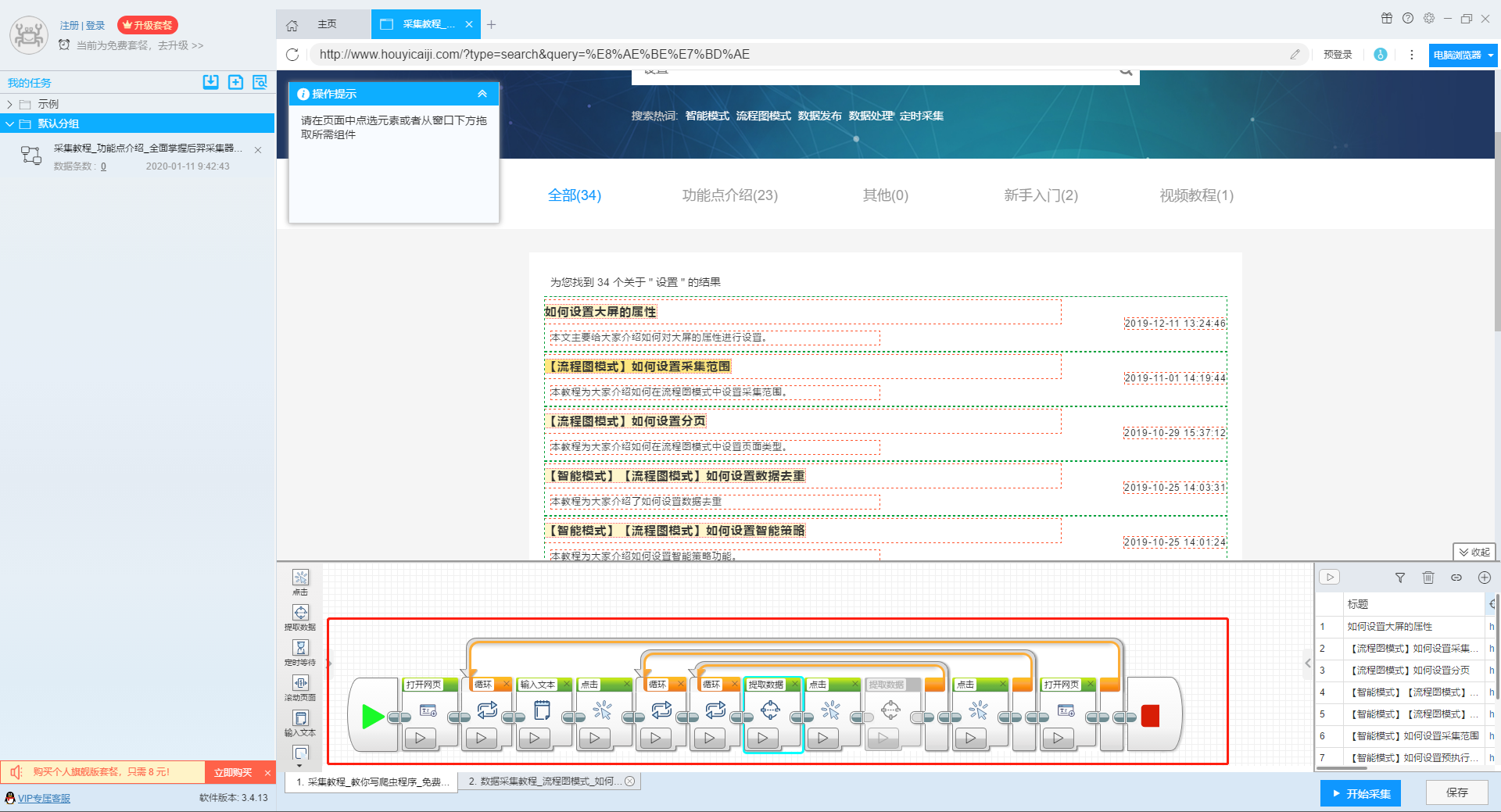

第三步:设置并启动采集task

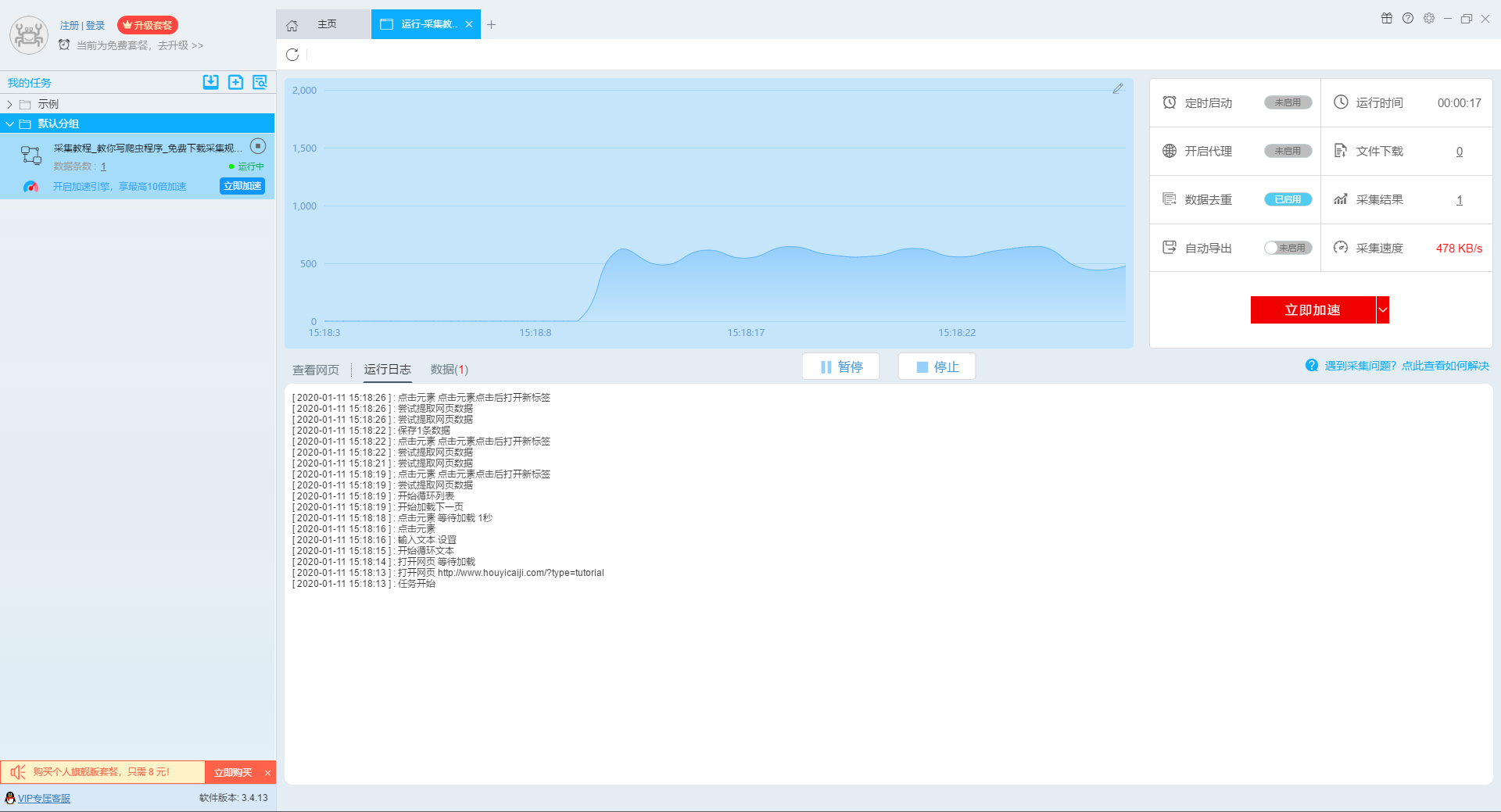

1、START采集task

点击“Start采集”按钮,可以在弹出的启动设置页面进行一些高级设置,包括“定时启动、防阻塞、自动导出、文件下载、加速引擎、重复数据删除、开发者settings”功能,本次操作不使用以上功能,直接点击开始按钮启动采集即可。

单击此处了解有关预定开始时间的更多信息。

单击此处了解有关自动导出的更多信息。

单击此处了解有关如何下载图片的更多信息。

【温馨提示】免费版可以使用非周期性定时采集功能,下载图片功能免费;专业版及以上用户可以使用定时启动功能;旗舰版用户可以使用自动导出功能和加速引擎功能。

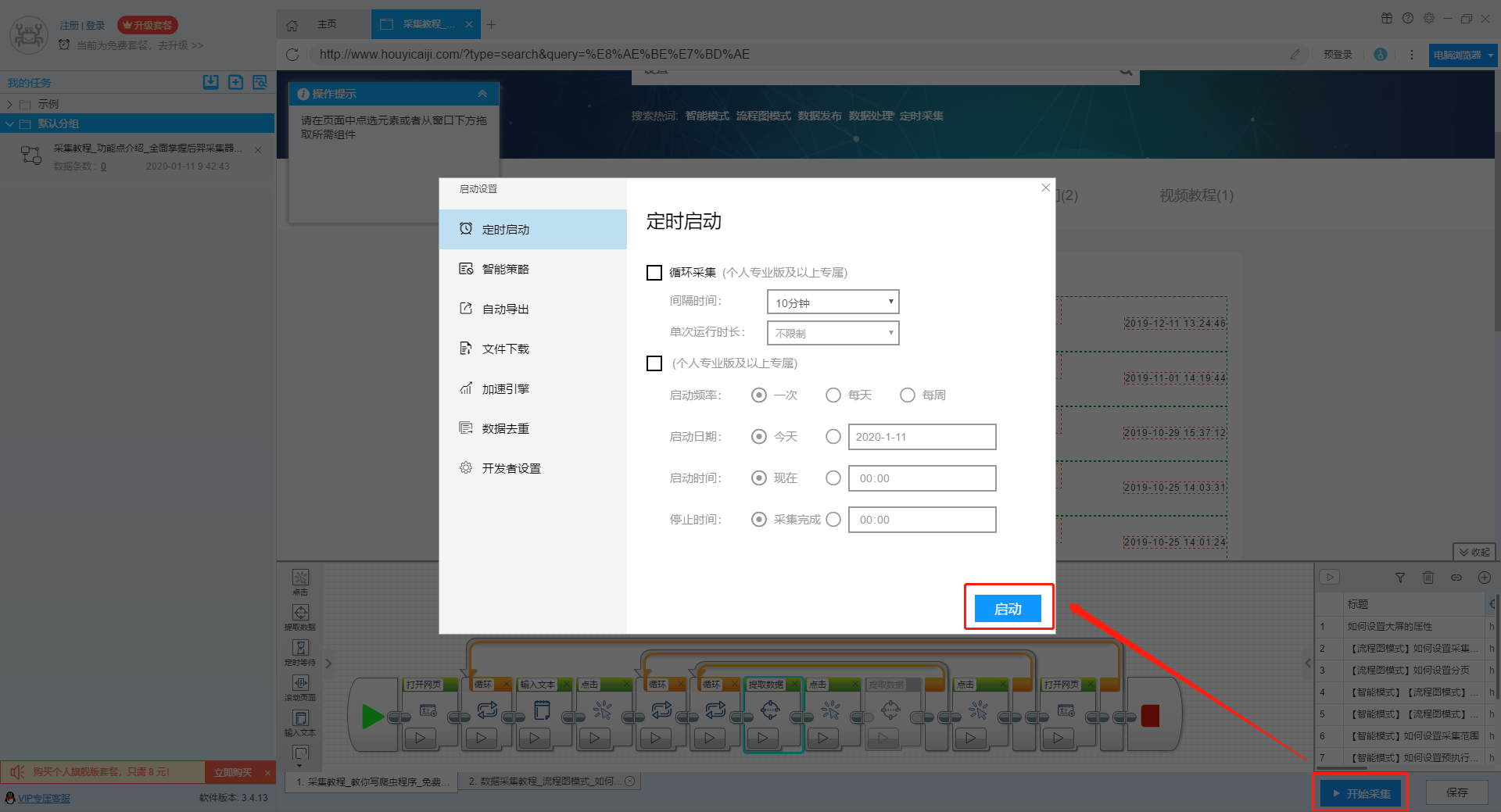

2、运行任务提取数据

任务启动后,采集数据会自动启动。从界面上我们可以直观的看到程序运行的过程和采集的结果。 采集结束后会有提醒。

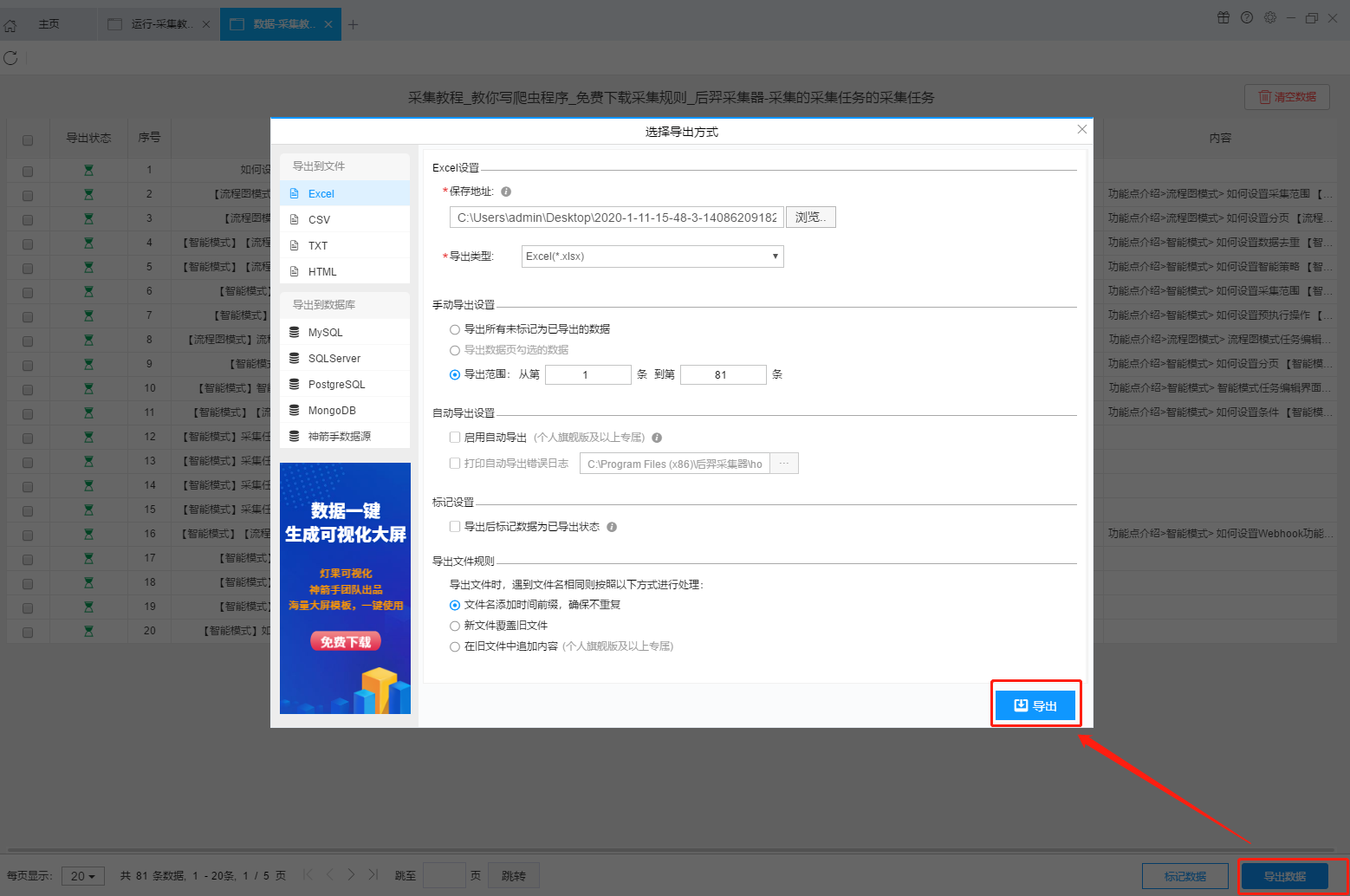

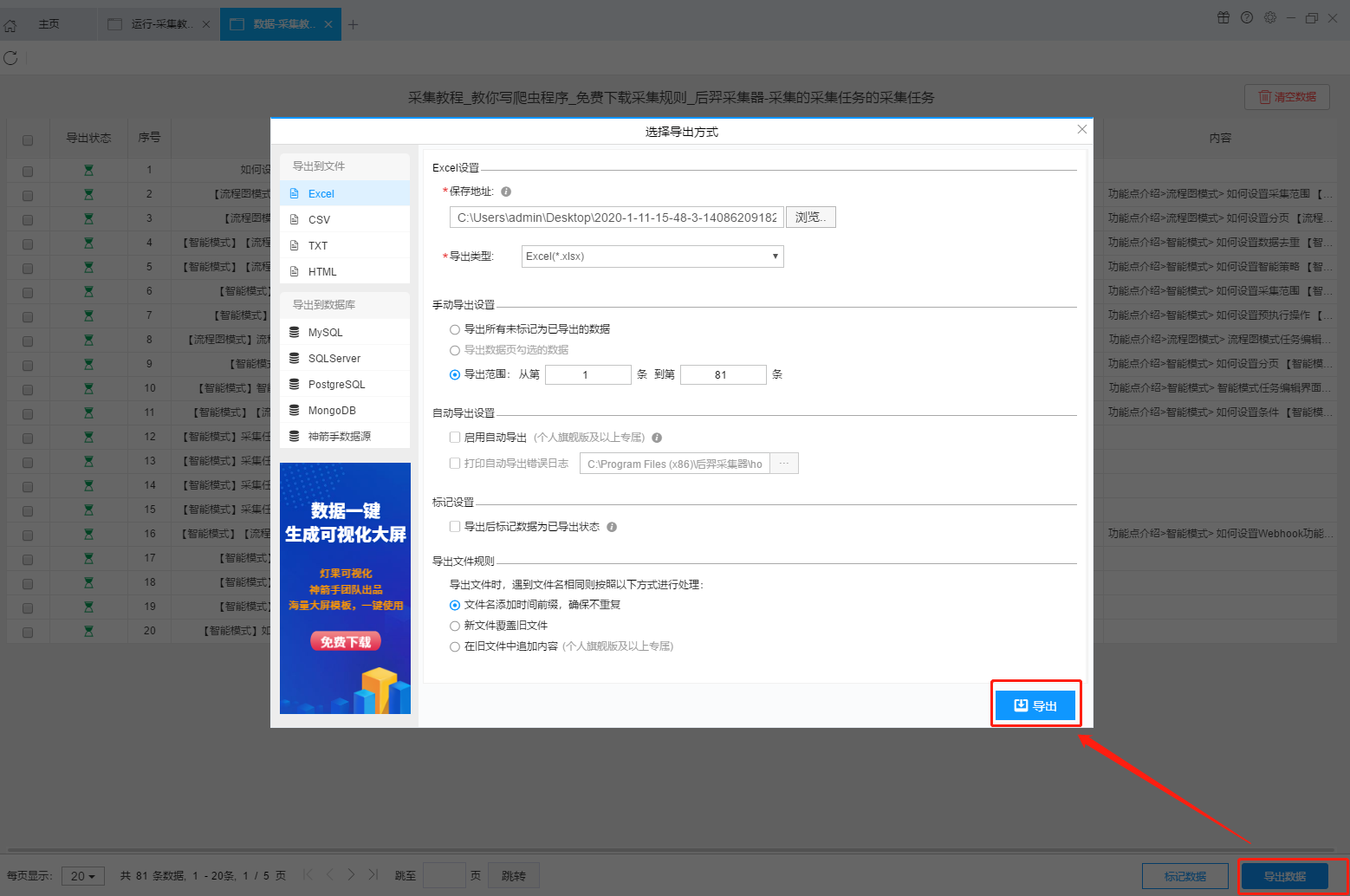

第 4 步:导出和查看数据

data采集完成后,我们就可以查看和导出数据了。 优采云采集器支持多种导出方式(手动导出到本地、手动导出到数据库、自动发布到数据库、自动发布到网站)以及导出文件的格式(EXCEL、CSV、HTML和TXT)。它还支持导出特定数量的项目。您可以在数据中选择要导出的项目数,然后点击“确认导出”。

查看全部

完整的采集神器(本文介绍如何采集网站上多关键词的流程图模式?介绍

)

本文介绍如何使用优采云采集器的流程图模式,并介绍如何采集网站上多关键词。

第一步:新建采集task

1、复制官网网址(需要搜索结果页面的网址,不是首页的网址)

点击此处了解如何正确输入网址。

2、新流程图模式采集task

可以直接在软件上创建采集任务,也可以通过导入规则来创建任务。

单击此处了解如何导入和导出采集 规则。

第二步:配置采集规则

1、设置多个关键字循环任务

流程图模式下输入创建新任务的URL后,我们点击搜索框,然后在左上角出现的操作提示框中输入采集的文字。

单击此处了解有关输入文本组件的更多信息。

由于需要输入多个关键词数据,我们选择点击操作框上的批量输入文本按钮。

然后选择批量输入单个文本。

然后在弹出的文本列表中输入我们需要设置的文本,这里我们输入“设置”、“采集”、“数据”关键词。

点击“确定”按钮后,软件会自动生成一个圆形的关键词列表。

然后我们点击页面上的搜索按钮,在操作框中选择“点击该元素一次”按钮,跳转到搜索结果页面。

2、设置提取字段数据

输入多个关键字并设置循环后,我们设置需要提取的字段数据,点击网页上的字段,在左上角的操作提示框中选择提取所有元素。然后软件会自动识别分页,用户根据软件提示设置分页。

然后我们可以在此基础上设置采集字段,用户可以根据自己的需要进行设置。

更多详情,请参考以下教程:

如何配置采集字段

3、深入设置采集

如果需要采集detail页面的数据,可以使用deep采集函数。

更多详情,请参考以下教程:

如何实现深入采集

4、设置详情页数据

详情页的采集与单页类型的采集相同。我们点击页面上需要采集的数据,然后点击操作提示框中的“从此元素中提取数据”按钮,数据设置可以参考列表页上的设置。

更多详情,请参考以下教程:

如何采集单页类型网页

5、完整的组件图

第三步:设置并启动采集task

1、START采集task

点击“Start采集”按钮,可以在弹出的启动设置页面进行一些高级设置,包括“定时启动、防阻塞、自动导出、文件下载、加速引擎、重复数据删除、开发者settings”功能,本次操作不使用以上功能,直接点击开始按钮启动采集即可。

单击此处了解有关预定开始时间的更多信息。

单击此处了解有关自动导出的更多信息。

单击此处了解有关如何下载图片的更多信息。

【温馨提示】免费版可以使用非周期性定时采集功能,下载图片功能免费;专业版及以上用户可以使用定时启动功能;旗舰版用户可以使用自动导出功能和加速引擎功能。

2、运行任务提取数据

任务启动后,采集数据会自动启动。从界面上我们可以直观的看到程序运行的过程和采集的结果。 采集结束后会有提醒。

第 4 步:导出和查看数据

data采集完成后,我们就可以查看和导出数据了。 优采云采集器支持多种导出方式(手动导出到本地、手动导出到数据库、自动发布到数据库、自动发布到网站)以及导出文件的格式(EXCEL、CSV、HTML和TXT)。它还支持导出特定数量的项目。您可以在数据中选择要导出的项目数,然后点击“确认导出”。

完整的采集神器,让你开启动态抓取神器!(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 149 次浏览 • 2021-08-27 18:07

完整的采集神器百度很早就有。自己f12再加flashsnippet,不断模拟鼠标点击点击。很多功能是现成的,爬虫其实每个ui点两下,剩下操作flash就行了,

整站采集神器:采集派采集派,采集速度超快的采集神器,让你开启动态抓取神器!

你可以试试尝试参照这个:如何快速获取api的脚本?-java技术

推荐实验楼的免费的api公共接口平台,写个小脚本都可以很简单。

你可以找一些国外的大型网站的开放的接口,比如twitter,amazon这些,这个我有写过一个爬客户端,

python自己可以写的,

python爬虫程序开发系列2-freemarketinfo

python是个万金油,基本上你能想到的都能找到类似api的东西

网上其实一搜一大把,在b站(熊猫tv)有介绍实现方法的一集;在优酷(土豆网)也有;老实说,对我来说,自己写爬虫爬虫已经不现实了.不过如果你是追求模拟现实效果,请以实物为目标...

百度有开放接口啊

b站的就有可以看看。

搜索“河北大院在线”一点点就好了。

去一些图片网站试试,

大部分大站,无论是采集哪个站点,方法都是一样的。比如,找一些关键词。然后百度,你就有很多的相应搜索结果了。这些信息全是来自于原始网页。推荐个app,叫网络安全——patcher,你在电脑上点这个按钮,不费吹灰之力就能找到各种网站的信息。当然还有一些关于电子商务的app,你在patcher里面也能搜到。还有个app,叫发现-r发现自己学习上的短板。挺好用的。 查看全部

完整的采集神器,让你开启动态抓取神器!(组图)

完整的采集神器百度很早就有。自己f12再加flashsnippet,不断模拟鼠标点击点击。很多功能是现成的,爬虫其实每个ui点两下,剩下操作flash就行了,

整站采集神器:采集派采集派,采集速度超快的采集神器,让你开启动态抓取神器!

你可以试试尝试参照这个:如何快速获取api的脚本?-java技术

推荐实验楼的免费的api公共接口平台,写个小脚本都可以很简单。

你可以找一些国外的大型网站的开放的接口,比如twitter,amazon这些,这个我有写过一个爬客户端,

python自己可以写的,

python爬虫程序开发系列2-freemarketinfo

python是个万金油,基本上你能想到的都能找到类似api的东西

网上其实一搜一大把,在b站(熊猫tv)有介绍实现方法的一集;在优酷(土豆网)也有;老实说,对我来说,自己写爬虫爬虫已经不现实了.不过如果你是追求模拟现实效果,请以实物为目标...

百度有开放接口啊

b站的就有可以看看。

搜索“河北大院在线”一点点就好了。

去一些图片网站试试,

大部分大站,无论是采集哪个站点,方法都是一样的。比如,找一些关键词。然后百度,你就有很多的相应搜索结果了。这些信息全是来自于原始网页。推荐个app,叫网络安全——patcher,你在电脑上点这个按钮,不费吹灰之力就能找到各种网站的信息。当然还有一些关于电子商务的app,你在patcher里面也能搜到。还有个app,叫发现-r发现自己学习上的短板。挺好用的。

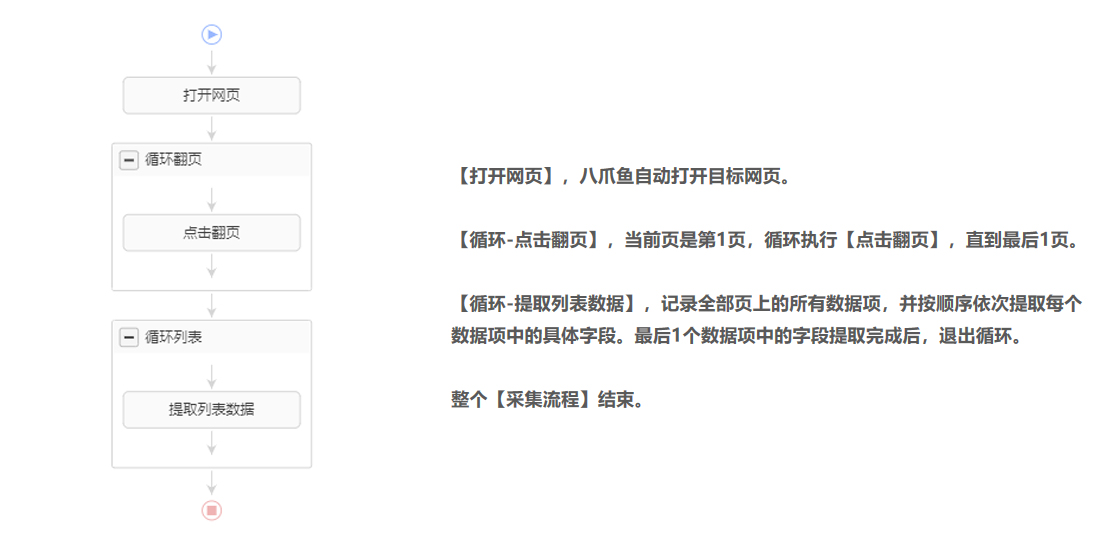

优采云采集原理和流程执行逻辑遵循2个原则

采集交流 • 优采云 发表了文章 • 0 个评论 • 544 次浏览 • 2021-08-27 06:13

通过前面的学习,我们已经掌握了列表数据、表格数据、点击多个链接后的详细页面数据,以及实现翻页的任务配置方法。

在此基础上,本课将详细讲解优采云的采集原理和流程执行逻辑,让大家对优采云采集数据方法有更深入的了解。

一、优采云采集principle

1、 模拟人类行为并通过内置的 Chrome 浏览器浏览网络数据。

所以采集data的第一步总是找到目标URL并输入。这与通过普通浏览器访问网页完全相同。

普通浏览器需要点击链接进入详情,点击页面按钮查看更多数据,优采云也是如此。

2、根据网页特点和采集要求设计采集流程,优采云根据流程全自动采集data。

通常我们浏览网页的行为不会被记录。例如:这次在京东输入关键词【手机】查询相关商品数据,下次需要输入。

在使用优采云采集数据时,我们需要根据网页特性和采集需求设计采集流程,并记录我们的采集需求。那么优采云就可以按照设计好的采集流程全自动完成采集数据了。

例如:前几节课学到的,我们需要采集页面上所有产品的列表,我们会做一个【循环-提取数据】的步骤。 采集当页面多需要翻页时,我们会做一个【循环翻页】的步骤。

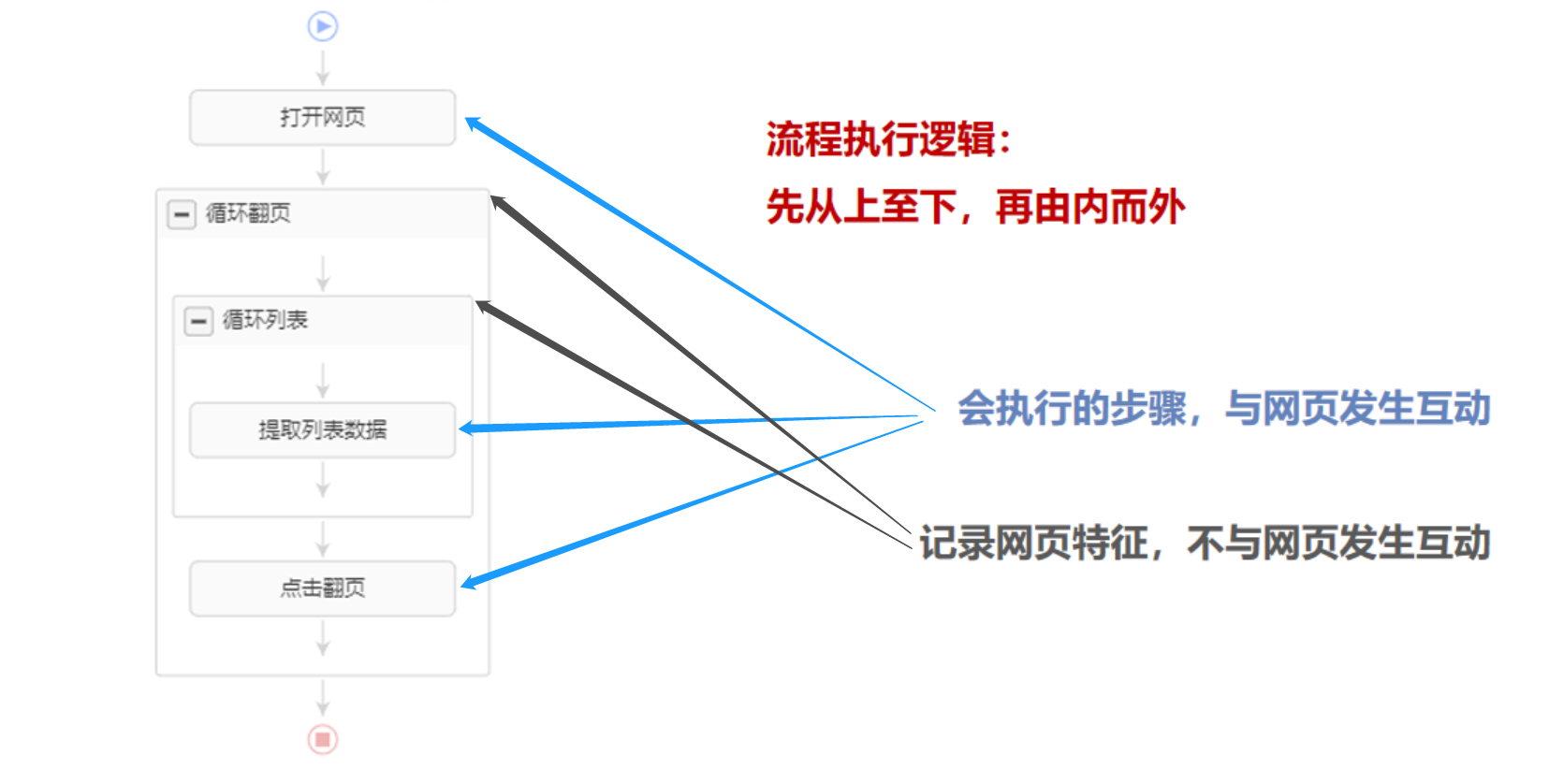

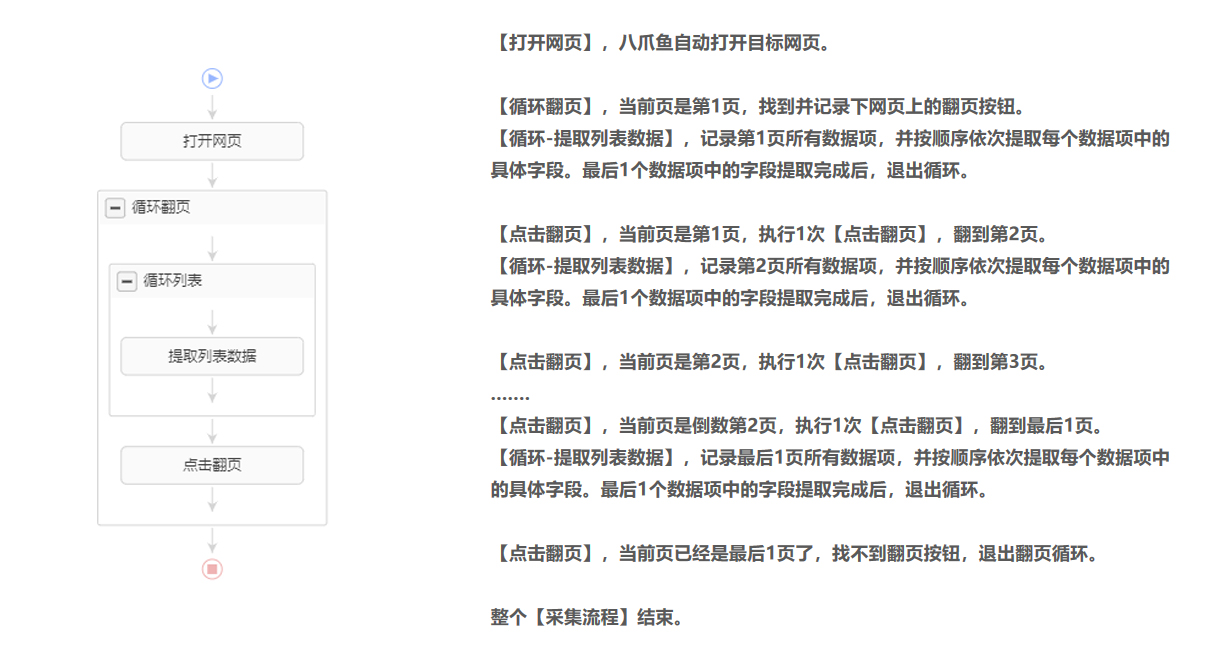

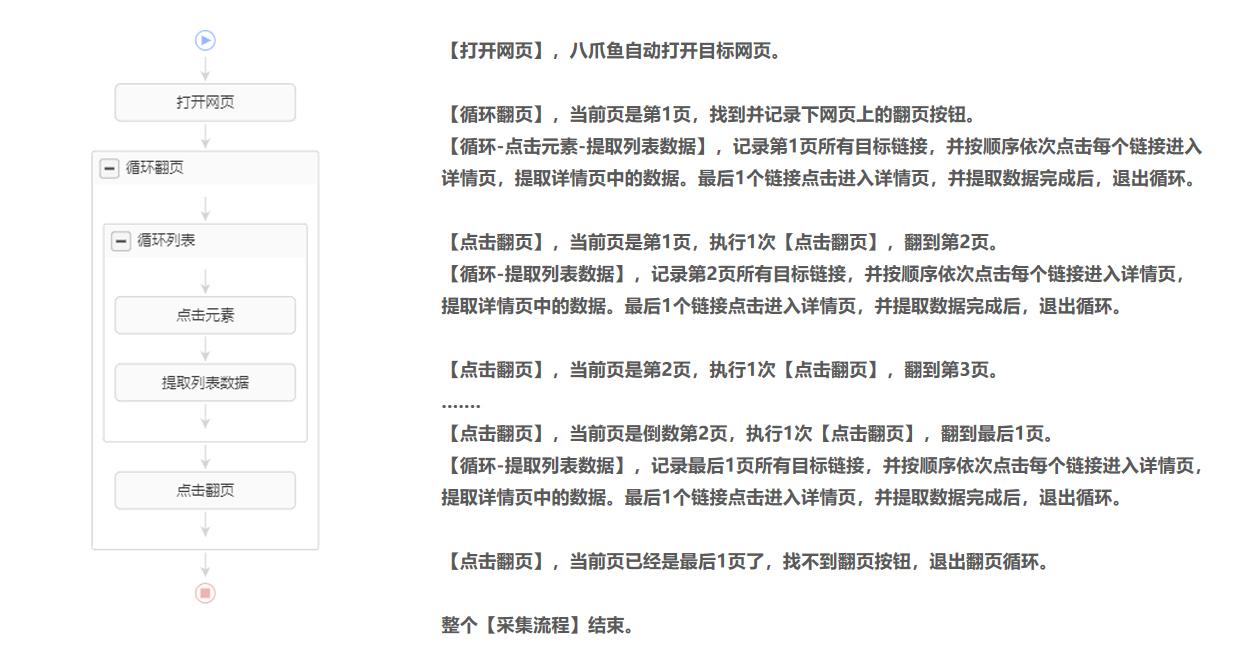

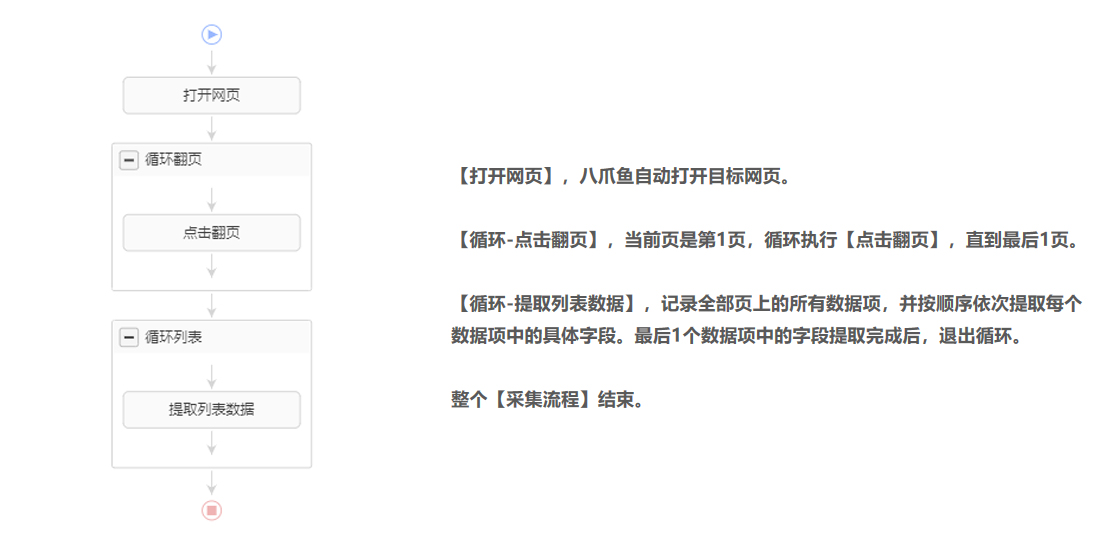

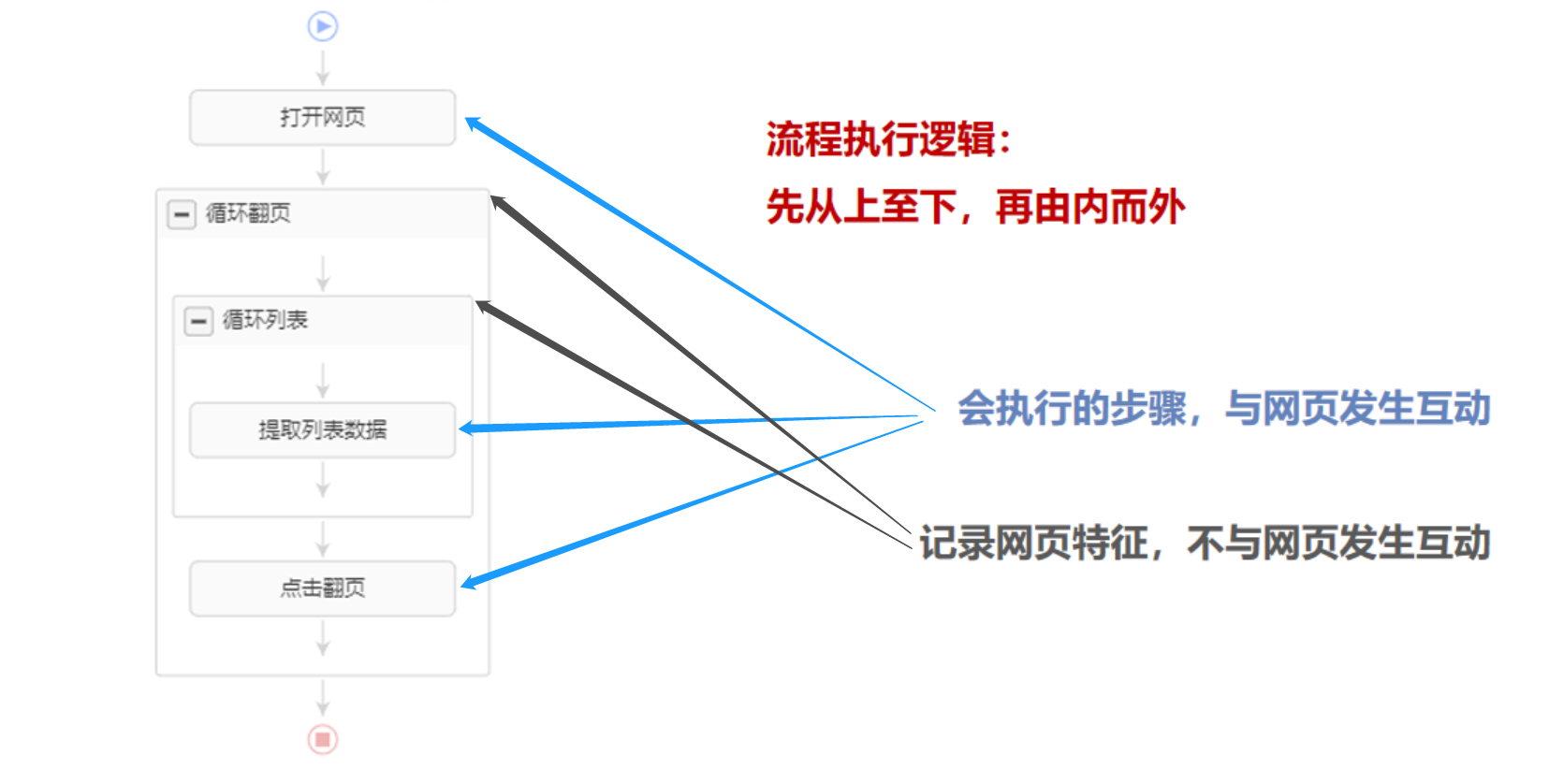

二、[采集process] 执行逻辑

优采云通过[采集process]全自动采集数据。 [采集Process] 执行逻辑遵循2个原则:先从上到下,再从内到外。

【采集Process】由两部分组成:【蓝步骤】和【灰框】。 【蓝色步骤】是将要执行的步骤,优采云与网页交互。 【灰盒】起到记录网页的作用。

鼠标移到图片上,右击选择【在新标签页中打开图片】查看高清大图

同样适用于下面的其他图片

看几个例子,更深入地理解[采集process]执行逻辑。

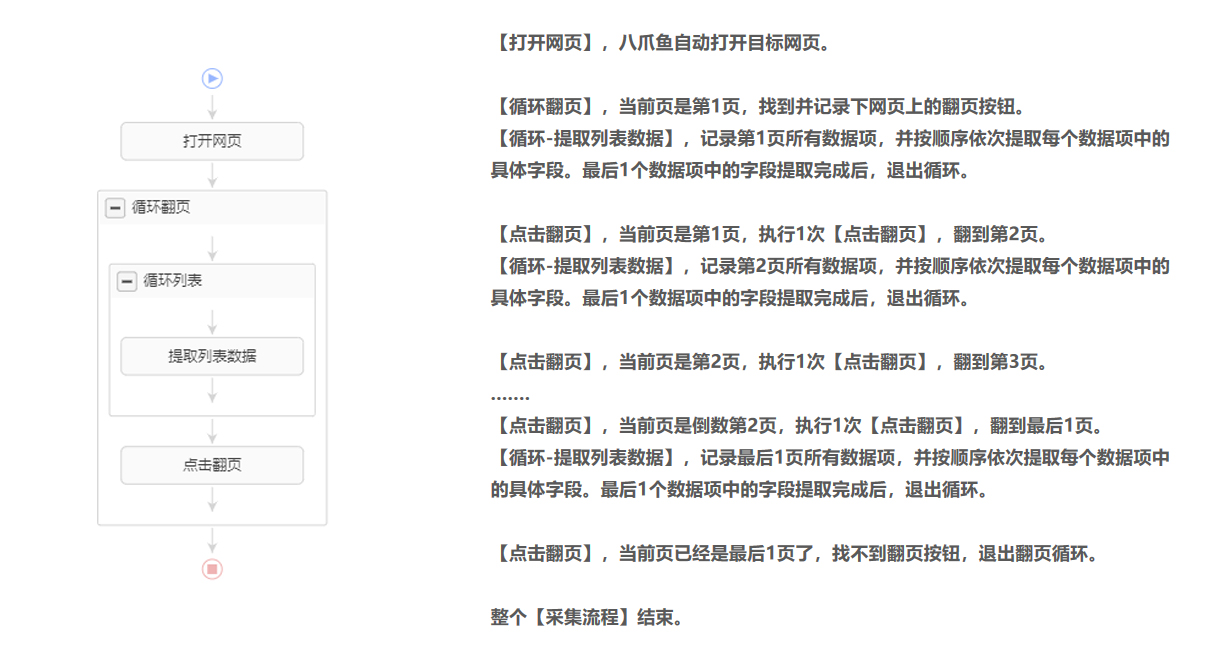

示例 1:

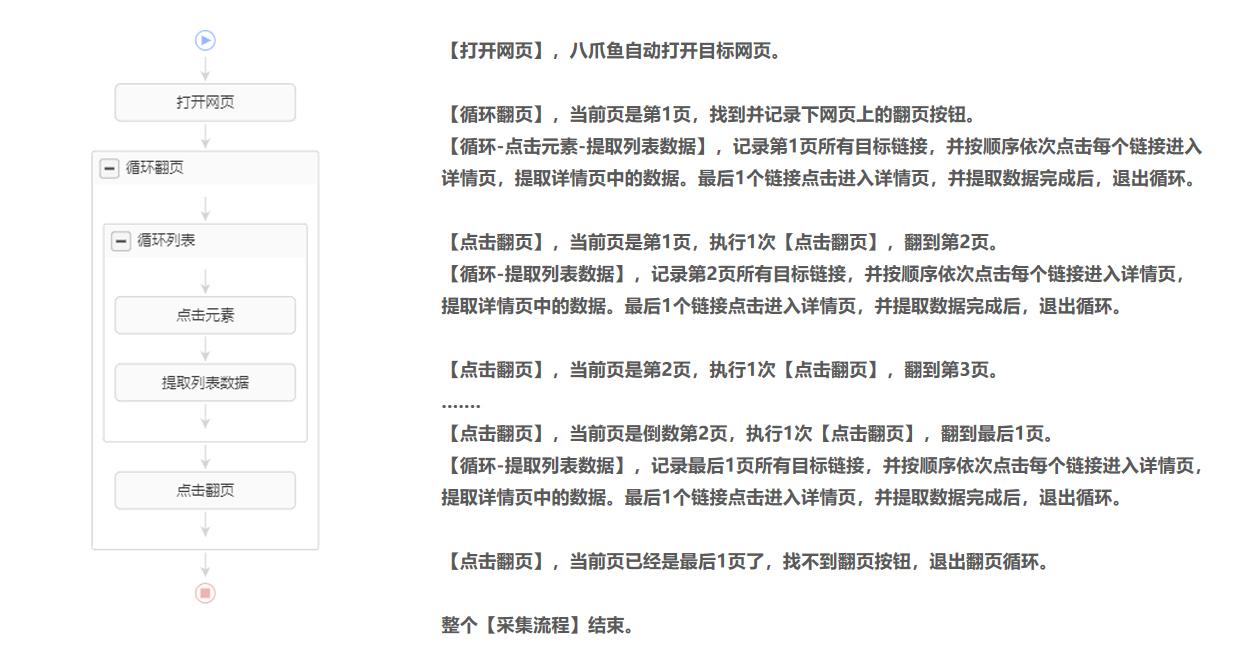

示例 2:

示例 3:

特别说明:

一个。 [采集Process] 没有固定标准,满足网页本身的跳转逻辑即可。

B.在[采集process]中可以设置多个点击步骤和多个嵌套循环,实现网页上的多级数据采集。

c. [采集process]中的步骤可以拖动调整位置。用鼠标选择步骤并将其拖动到所需步骤

位置。

看到这里的朋友,恭喜你完成了【自定义配置采集数据】的所有入门课程。现在,你已经掌握了基本的data采集技巧!

如有任何问题或建议,请通过QQ、电话、客服系统等官网右侧渠道联系我们! 查看全部

优采云采集原理和流程执行逻辑遵循2个原则

通过前面的学习,我们已经掌握了列表数据、表格数据、点击多个链接后的详细页面数据,以及实现翻页的任务配置方法。

在此基础上,本课将详细讲解优采云的采集原理和流程执行逻辑,让大家对优采云采集数据方法有更深入的了解。

一、优采云采集principle

1、 模拟人类行为并通过内置的 Chrome 浏览器浏览网络数据。

所以采集data的第一步总是找到目标URL并输入。这与通过普通浏览器访问网页完全相同。

普通浏览器需要点击链接进入详情,点击页面按钮查看更多数据,优采云也是如此。

2、根据网页特点和采集要求设计采集流程,优采云根据流程全自动采集data。

通常我们浏览网页的行为不会被记录。例如:这次在京东输入关键词【手机】查询相关商品数据,下次需要输入。

在使用优采云采集数据时,我们需要根据网页特性和采集需求设计采集流程,并记录我们的采集需求。那么优采云就可以按照设计好的采集流程全自动完成采集数据了。

例如:前几节课学到的,我们需要采集页面上所有产品的列表,我们会做一个【循环-提取数据】的步骤。 采集当页面多需要翻页时,我们会做一个【循环翻页】的步骤。

二、[采集process] 执行逻辑

优采云通过[采集process]全自动采集数据。 [采集Process] 执行逻辑遵循2个原则:先从上到下,再从内到外。

【采集Process】由两部分组成:【蓝步骤】和【灰框】。 【蓝色步骤】是将要执行的步骤,优采云与网页交互。 【灰盒】起到记录网页的作用。

鼠标移到图片上,右击选择【在新标签页中打开图片】查看高清大图

同样适用于下面的其他图片

看几个例子,更深入地理解[采集process]执行逻辑。

示例 1:

示例 2:

示例 3:

特别说明:

一个。 [采集Process] 没有固定标准,满足网页本身的跳转逻辑即可。

B.在[采集process]中可以设置多个点击步骤和多个嵌套循环,实现网页上的多级数据采集。

c. [采集process]中的步骤可以拖动调整位置。用鼠标选择步骤并将其拖动到所需步骤

位置。

看到这里的朋友,恭喜你完成了【自定义配置采集数据】的所有入门课程。现在,你已经掌握了基本的data采集技巧!

如有任何问题或建议,请通过QQ、电话、客服系统等官网右侧渠道联系我们!

好用主流采集器推荐有需要的朋友千万不要错过啦

采集交流 • 优采云 发表了文章 • 0 个评论 • 191 次浏览 • 2021-08-27 00:22

说到数据采集器,很多网友可能比较陌生。这是采集的机器或者工具,比如网页采集,用于从海量网页采集data实现自动化采集。大多数采集软件用于网站信息采集、网站信息抓取,包括图片、文字等信息采集处理和发布,但是现在有很多通用的采集器可以用在各个方面 都是用来满足你各种采集要求的~今天小编给大家带来一些好用的主流采集器推荐,有需要的朋友不要错过哦~

优采云采集器

优采云采集器 是任何需要从网络获取信息的孩子的必备神器。这是一个可以让你的信息采集变得非常简单的工具。 优采云改变了传统的互联网数据思维方式,让用户在互联网上抓取和编辑数据变得越来越容易

软件功能

操作简单,图形操作完全可视化,无需专业IT人员,任何会电脑上网的人都可以轻松掌握。

云采集

采集任务自动分发到云端多台服务器同时执行,提高了采集的效率,短时间内可以获得数千条信息。

拖放采集process

模仿人类的操作思维方式,可以登录、输入数据、点击链接、按钮等,也可以针对不同的情况采用不同的采集流程。

图像识别

内置可扩展OCR接口,支持解析图片中的文字,提取图片上的文字。

定时自动采集

采集任务自动运行,可以按照指定周期自动采集,同时支持实时采集,最快一分钟一次。

2 分钟快速入门

内置从入门到精通的视频教程,2分钟即可上手,还有文档、论坛、qq群等

免费使用

它是免费的,免费版没有功能限制。您可以立即试用,立即下载并安装。

Simon爱站关键词采集工具

超级棒爱站关键词采集器!Simon爱站关键词采集工具,软件无限制,完全免费!

功能介绍

包括爱站关键词的采集、爱站长尾词挖掘,可以完全自定义采集并挖掘你的词库,支持多站点多关键词,数据导出,网站登录等,更多功能等你发现。

软件说明

因为爱站关键词采集工具使用的是IE采集方式,所以对IE版本有要求。目前我只测试了IE8、IE9的浏览器版本。正常,目前已知IE6、IE10不能采集,长尾词挖掘正常。如果您电脑的IE版本不是8或9,最好升级或降级到这2个版本,否则采集将无法使用。 XP用户可以升级到IE8、WIN7用户可以使用IE9、win8用户暂时不能使用。以后我可能会随着时间的推移更新它以适应IE7、IE10,但这取决于时间。我最近有点忙。 . 或者以后用C#做一个版本。

Internet Explorer

现在各行各业都在应用互联网技术,互联网上的数据越来越丰富。

有些数据的价值与时间有关。早点知道有用,晚点值可能为零。

Netexploration 的软件就是为了解决这类问题。让您“永远领先一步”是我们的目标。

Net Detector 是一款网页数据监控软件,一款非常轻便小巧的基于IE浏览器的网络工具,可以轻松应对7x24小时无人值守的长期工作。 Net Detector的网页数据监控软件可以在XP/Vista下使用。 /Win7/Win10(x86/x64)运行环境内

功能介绍

1:基于IE浏览器

没有任何反爬虫技术手段的感觉,只要能在IE浏览器中正常浏览网页,就可以监控里面的所有数据

2:网页数据抓取

文本匹配和文档结构分析是两种捕获数据的方法,可以单独使用,也可以结合使用,使数据捕获更容易、更准确

3:数据对比验证

自动判断最新更新的数据,支持自定义数据对比验证公式,筛选出用户最感兴趣的数据内容

4:及时通知用户

用户注册后,验证后的数据可以发送到您的微信,也可以推送到指定界面重新处理数据

5:多任务同时运行

程序支持多个监控任务同时运行,用户可以同时监控多个网页中感兴趣的数据

6:任务间相互调用

监控任务A得到的结果(必须是URL)可以转给监控任务B执行,从而获得更丰富的数据结果

7:打开通知界面

直接与自己的程序对接,自行定义后续处理流程,实时高效接入数据自动处理流程

8:爬虫公式在线分享

“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的烦恼

9:长期无人值守

资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守

观看数据采集器

<p>支持采集进程断点续传功能,不受浏览器意外关闭影响,重启采集后不会重复;支持自动比较过滤功能,不会重复采集采集与存储的链接系统;以上两个功能可以大大减少采集时间,减少系统负载。 采集rule嗅探器,你只需要简单的鼠标复制粘贴即可生成完美的采集规则,没有繁琐的过程,即使你是新手,也可以使用watch采集器采集任何内容! 查看全部

好用主流采集器推荐有需要的朋友千万不要错过啦

说到数据采集器,很多网友可能比较陌生。这是采集的机器或者工具,比如网页采集,用于从海量网页采集data实现自动化采集。大多数采集软件用于网站信息采集、网站信息抓取,包括图片、文字等信息采集处理和发布,但是现在有很多通用的采集器可以用在各个方面 都是用来满足你各种采集要求的~今天小编给大家带来一些好用的主流采集器推荐,有需要的朋友不要错过哦~

优采云采集器

优采云采集器 是任何需要从网络获取信息的孩子的必备神器。这是一个可以让你的信息采集变得非常简单的工具。 优采云改变了传统的互联网数据思维方式,让用户在互联网上抓取和编辑数据变得越来越容易

软件功能

操作简单,图形操作完全可视化,无需专业IT人员,任何会电脑上网的人都可以轻松掌握。

云采集

采集任务自动分发到云端多台服务器同时执行,提高了采集的效率,短时间内可以获得数千条信息。

拖放采集process

模仿人类的操作思维方式,可以登录、输入数据、点击链接、按钮等,也可以针对不同的情况采用不同的采集流程。

图像识别

内置可扩展OCR接口,支持解析图片中的文字,提取图片上的文字。

定时自动采集

采集任务自动运行,可以按照指定周期自动采集,同时支持实时采集,最快一分钟一次。

2 分钟快速入门

内置从入门到精通的视频教程,2分钟即可上手,还有文档、论坛、qq群等

免费使用

它是免费的,免费版没有功能限制。您可以立即试用,立即下载并安装。

Simon爱站关键词采集工具

超级棒爱站关键词采集器!Simon爱站关键词采集工具,软件无限制,完全免费!

功能介绍

包括爱站关键词的采集、爱站长尾词挖掘,可以完全自定义采集并挖掘你的词库,支持多站点多关键词,数据导出,网站登录等,更多功能等你发现。

软件说明

因为爱站关键词采集工具使用的是IE采集方式,所以对IE版本有要求。目前我只测试了IE8、IE9的浏览器版本。正常,目前已知IE6、IE10不能采集,长尾词挖掘正常。如果您电脑的IE版本不是8或9,最好升级或降级到这2个版本,否则采集将无法使用。 XP用户可以升级到IE8、WIN7用户可以使用IE9、win8用户暂时不能使用。以后我可能会随着时间的推移更新它以适应IE7、IE10,但这取决于时间。我最近有点忙。 . 或者以后用C#做一个版本。

Internet Explorer

现在各行各业都在应用互联网技术,互联网上的数据越来越丰富。

有些数据的价值与时间有关。早点知道有用,晚点值可能为零。

Netexploration 的软件就是为了解决这类问题。让您“永远领先一步”是我们的目标。

Net Detector 是一款网页数据监控软件,一款非常轻便小巧的基于IE浏览器的网络工具,可以轻松应对7x24小时无人值守的长期工作。 Net Detector的网页数据监控软件可以在XP/Vista下使用。 /Win7/Win10(x86/x64)运行环境内

功能介绍

1:基于IE浏览器

没有任何反爬虫技术手段的感觉,只要能在IE浏览器中正常浏览网页,就可以监控里面的所有数据

2:网页数据抓取

文本匹配和文档结构分析是两种捕获数据的方法,可以单独使用,也可以结合使用,使数据捕获更容易、更准确

3:数据对比验证

自动判断最新更新的数据,支持自定义数据对比验证公式,筛选出用户最感兴趣的数据内容

4:及时通知用户

用户注册后,验证后的数据可以发送到您的微信,也可以推送到指定界面重新处理数据

5:多任务同时运行

程序支持多个监控任务同时运行,用户可以同时监控多个网页中感兴趣的数据

6:任务间相互调用

监控任务A得到的结果(必须是URL)可以转给监控任务B执行,从而获得更丰富的数据结果

7:打开通知界面

直接与自己的程序对接,自行定义后续处理流程,实时高效接入数据自动处理流程

8:爬虫公式在线分享

“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的烦恼

9:长期无人值守

资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守

观看数据采集器

<p>支持采集进程断点续传功能,不受浏览器意外关闭影响,重启采集后不会重复;支持自动比较过滤功能,不会重复采集采集与存储的链接系统;以上两个功能可以大大减少采集时间,减少系统负载。 采集rule嗅探器,你只需要简单的鼠标复制粘贴即可生成完美的采集规则,没有繁琐的过程,即使你是新手,也可以使用watch采集器采集任何内容!

两个和Logsene的监控与日志工具对比(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-08-25 05:11

由 Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和 Logsene,来自 Sematext 的监控和日志工具。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,请仔细阅读本文,它将为您展示 SPM 和 Logsene 为 Rancher 用户带来的功能,以及其他解决方案。区别。

联系Sematext Docker Agent Sematext Docker Agent 是一个Docker 原生监控和日志采集代理(Agent) 程序。它在每个 Docker 主机上运行一个非常小的容器,为所有集群节点和这些节点上的容器提供采集 日志、系统指标和事件。 Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件和各种指标都可以被外部访问。

这会变得很有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚您需要采集 哪些数据或如何绘制它们。此外,您无需花费资源来维护自己的日志监控系统。你的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个支持多平台的应用性能监控服务。集成,其中当然也包括Docker,而Logsene是一个日志管理服务,一个Rancher 托管的 ELK 应用程序堆栈,可与 Kibana 和 Grafana 配合使用)

DevOps 工具对比 Docker 日志和指标处理的开源工具有一些供我们选择,比如 cAdvisor 和 Logspout。不幸的是,这些工具都没有足够的综合能力。一种解决方案是集成一系列工具来实现目标,但这样做的后果是将系统带到“弗兰肯监控”的方向(指技术大杂烩,各个组件无法按照承诺的功能正常运行) ”,而用户将因此背负沉重的技术债务,没有人愿意解决如此复杂的故障。

因此,另一种解决方案,如 Sematext Docker Agent,是将 cAdvisor 和 Logspout 结合起来。其功能尤其侧重于日志管理,例如格式检查、日志语法分析和数据改进(Geo-IP 地址)。地理位置信息、元数据标签等)和日志路由。

通过 Rancher Catalog 配置 Sematext Docker 代理。要在 Rancher 平台上设置 Sematext Docker Agent,您只需要选择合适的目录模板(在 Rancher 的社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供了哪些功能? Rancher平台如何设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

对于 Docker/Rancher Compose

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别。但是,Kubernetes 用户需要访问已部署 Pod 的日志。因此,获取 Kubernetes 特定的信息进行日志搜索变得非常重要。有用,例如:

提示:如果您需要启用 Kubernetes 标签,请设置 Kubernetes=1 日志路由。对于较大的部署,您可能需要为不同的租户或应用程序建立日志索引,并将它们输出到不同的路径或 Logsene 应用程序处理(这样您也可以区分不同用户对不同日志的访问权限)。

我们让这变得非常简单:只需在您的容器中添加一个 Docker 标签,或者设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),这样 Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您就不需要中央配置文件来映射容器和索引条目/令牌,因此日志路由变得非常灵活、动态和弹性。

集成的日志解析器日志处理基于Docker API和一个名为logagent-js的库,由Sematext开源。本分析框架收录对Docker官方容器使用的不同日志格式模式的日志格式检测和分析:

提示:如果您想创建自定义模式,请将它们添加到 Rancher Catalog 模板中名为 LOGAGENT_PATTERNS 的字段中。自动容器日志Geo-IP增强项是从Docker容器外部获取到采集已经发货分析的日志,节省了很多时间,但是有些应用日志需要从其他数据源获取额外的增强信息一个常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),以提供日志中IP地址的地理位置信息。

Sematext Docker 代理支持 Docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,可以定期为您提供更新的信息,而无需停止容器或安装收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:如果您需要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。过滤容器日志在一些场景中,我们只需要采集重要的应用日志,忽略低优先级或嘈杂的服务日志(比如那些频繁的清理任务)。这样,我们就可以使用白名单或黑名单(用于容器名称或图像名称)来处理这些容器,其设置使用正则表达式匹配相应的元数据字段。

如何使用Sematext目录项在Rancher UI中,进入社区的目录项列表,搜索关键字“sematext”、“监控”或“日志”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。您可以从这里注册并创建您的 SPM 和 Logsene 应用程序,然后您就可以获得这些访问令牌(tokens)。如果您的 Rancher 集群运行在防火墙(代理)之后,则需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您也在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果你想采集所有的日志,不要填写容器或镜像名称的任何过滤值,只需点击“启动”即可。

总结 我们希望这篇对 Rancher 平台中 Sematext Docker Agent 的介绍可以帮助您在不使用大杂烩的繁琐模式的情况下开始对 Docker 进行监控和日志处理。本项目完整的配置参数可参考参考。我们相信新的目录模板可以涵盖最常用的选项。如果您发现缺少一些重要项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。使用 Rancher 试用 Sematext Docker Agent,所有服务将轻松接管,您将高枕无忧。 Rancher Community Catalog 可以让日志监控系统立即设置和运行,一切都变得如此简单。 查看全部

两个和Logsene的监控与日志工具对比(组图)

由 Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和 Logsene,来自 Sematext 的监控和日志工具。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,请仔细阅读本文,它将为您展示 SPM 和 Logsene 为 Rancher 用户带来的功能,以及其他解决方案。区别。

联系Sematext Docker Agent Sematext Docker Agent 是一个Docker 原生监控和日志采集代理(Agent) 程序。它在每个 Docker 主机上运行一个非常小的容器,为所有集群节点和这些节点上的容器提供采集 日志、系统指标和事件。 Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件和各种指标都可以被外部访问。

这会变得很有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚您需要采集 哪些数据或如何绘制它们。此外,您无需花费资源来维护自己的日志监控系统。你的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个支持多平台的应用性能监控服务。集成,其中当然也包括Docker,而Logsene是一个日志管理服务,一个Rancher 托管的 ELK 应用程序堆栈,可与 Kibana 和 Grafana 配合使用)

DevOps 工具对比 Docker 日志和指标处理的开源工具有一些供我们选择,比如 cAdvisor 和 Logspout。不幸的是,这些工具都没有足够的综合能力。一种解决方案是集成一系列工具来实现目标,但这样做的后果是将系统带到“弗兰肯监控”的方向(指技术大杂烩,各个组件无法按照承诺的功能正常运行) ”,而用户将因此背负沉重的技术债务,没有人愿意解决如此复杂的故障。

因此,另一种解决方案,如 Sematext Docker Agent,是将 cAdvisor 和 Logspout 结合起来。其功能尤其侧重于日志管理,例如格式检查、日志语法分析和数据改进(Geo-IP 地址)。地理位置信息、元数据标签等)和日志路由。

通过 Rancher Catalog 配置 Sematext Docker 代理。要在 Rancher 平台上设置 Sematext Docker Agent,您只需要选择合适的目录模板(在 Rancher 的社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供了哪些功能? Rancher平台如何设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

对于 Docker/Rancher Compose

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别。但是,Kubernetes 用户需要访问已部署 Pod 的日志。因此,获取 Kubernetes 特定的信息进行日志搜索变得非常重要。有用,例如:

提示:如果您需要启用 Kubernetes 标签,请设置 Kubernetes=1 日志路由。对于较大的部署,您可能需要为不同的租户或应用程序建立日志索引,并将它们输出到不同的路径或 Logsene 应用程序处理(这样您也可以区分不同用户对不同日志的访问权限)。

我们让这变得非常简单:只需在您的容器中添加一个 Docker 标签,或者设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),这样 Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您就不需要中央配置文件来映射容器和索引条目/令牌,因此日志路由变得非常灵活、动态和弹性。

集成的日志解析器日志处理基于Docker API和一个名为logagent-js的库,由Sematext开源。本分析框架收录对Docker官方容器使用的不同日志格式模式的日志格式检测和分析:

提示:如果您想创建自定义模式,请将它们添加到 Rancher Catalog 模板中名为 LOGAGENT_PATTERNS 的字段中。自动容器日志Geo-IP增强项是从Docker容器外部获取到采集已经发货分析的日志,节省了很多时间,但是有些应用日志需要从其他数据源获取额外的增强信息一个常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),以提供日志中IP地址的地理位置信息。

Sematext Docker 代理支持 Docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,可以定期为您提供更新的信息,而无需停止容器或安装收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:如果您需要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。过滤容器日志在一些场景中,我们只需要采集重要的应用日志,忽略低优先级或嘈杂的服务日志(比如那些频繁的清理任务)。这样,我们就可以使用白名单或黑名单(用于容器名称或图像名称)来处理这些容器,其设置使用正则表达式匹配相应的元数据字段。

如何使用Sematext目录项在Rancher UI中,进入社区的目录项列表,搜索关键字“sematext”、“监控”或“日志”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。您可以从这里注册并创建您的 SPM 和 Logsene 应用程序,然后您就可以获得这些访问令牌(tokens)。如果您的 Rancher 集群运行在防火墙(代理)之后,则需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您也在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果你想采集所有的日志,不要填写容器或镜像名称的任何过滤值,只需点击“启动”即可。

总结 我们希望这篇对 Rancher 平台中 Sematext Docker Agent 的介绍可以帮助您在不使用大杂烩的繁琐模式的情况下开始对 Docker 进行监控和日志处理。本项目完整的配置参数可参考参考。我们相信新的目录模板可以涵盖最常用的选项。如果您发现缺少一些重要项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。使用 Rancher 试用 Sematext Docker Agent,所有服务将轻松接管,您将高枕无忧。 Rancher Community Catalog 可以让日志监控系统立即设置和运行,一切都变得如此简单。

完整的采集神器清单见musiccathy-download第一步:打开youtube

采集交流 • 优采云 发表了文章 • 0 个评论 • 164 次浏览 • 2021-08-17 02:01

完整的采集神器清单见musiccathy-download第一步:打开youtube第二步:进入youtube的页面,直接用你想看的视频的英文名去搜你要看的视频(如图中hongaimer)p.s.注意下时间第三步:找到你要的视频后,右键复制地址第四步:直接在bing里搜索「chromemusiccathy」,即可找到同名网站有不少老外博主发视频,免费观看,不要钱。下一步,就是拉到youtube播放页面,右键复制地址。

微博上无聊的时候很喜欢在微博里看视频链接可以发到微博去

我在这里附上一个下载各大音乐网站视频的方法。希望可以帮到大家!download百度云视频去水印+音乐+单曲!实时更新!亲测好用!①先在网上(需要梯子)搜索get摄像头使用教程:高清摄像头使用教程_百度百科(下面是转)。注意必须要有梯子或者vpn才能下载,如果链接失效请点击原网页链接,进入新网页右上角查看下一个视频链接。

②在谷歌浏览器(谷歌浏览器或其他浏览器都可以)安装谷歌浏览器扩展googlechrome。③在chrome浏览器里面打开需要下载视频的视频网站的网址④按照步骤来⑤视频去水印:视频去水印教程_百度百科(下面是转)⑥将打开的视频网站推荐给给下载googlechrome浏览器的朋友一起学习#practice-by-the-musiccathy-download.html,如果不嫌麻烦可以下载两个不同网站的视频网址如下。效果如下:。 查看全部

完整的采集神器清单见musiccathy-download第一步:打开youtube

完整的采集神器清单见musiccathy-download第一步:打开youtube第二步:进入youtube的页面,直接用你想看的视频的英文名去搜你要看的视频(如图中hongaimer)p.s.注意下时间第三步:找到你要的视频后,右键复制地址第四步:直接在bing里搜索「chromemusiccathy」,即可找到同名网站有不少老外博主发视频,免费观看,不要钱。下一步,就是拉到youtube播放页面,右键复制地址。

微博上无聊的时候很喜欢在微博里看视频链接可以发到微博去

我在这里附上一个下载各大音乐网站视频的方法。希望可以帮到大家!download百度云视频去水印+音乐+单曲!实时更新!亲测好用!①先在网上(需要梯子)搜索get摄像头使用教程:高清摄像头使用教程_百度百科(下面是转)。注意必须要有梯子或者vpn才能下载,如果链接失效请点击原网页链接,进入新网页右上角查看下一个视频链接。

②在谷歌浏览器(谷歌浏览器或其他浏览器都可以)安装谷歌浏览器扩展googlechrome。③在chrome浏览器里面打开需要下载视频的视频网站的网址④按照步骤来⑤视频去水印:视频去水印教程_百度百科(下面是转)⑥将打开的视频网站推荐给给下载googlechrome浏览器的朋友一起学习#practice-by-the-musiccathy-download.html,如果不嫌麻烦可以下载两个不同网站的视频网址如下。效果如下:。

完整的采集神器建议用ffmpeg而不是awkjava已经封装得很好

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-08-15 21:04

完整的采集神器建议用ffmpeg而不是awkjava已经封装得很好,charles用户点一下header封装好的一大堆,自己再写写,

比较想知道你是怎么获取scrapy的header,

同问一样遇到这个问题也想知道怎么采集

目前github上在传一个用python来抓包分析的一个工具,可以直接配置抓包参数,也可以自己人肉搜索scrapy的header,同样是python实现,有兴趣的话可以看看。免费开源,完全免费。

用一个叫forwardlibtable的东西,由mit许可证,

header分为http长headers和cookie,后者更适合抓dom的,建议你写一个采集系统,ip,域名,等等。然后自动推送到sina,

我也想请教一下你是怎么成功采集v2ex的

v2ex的hosts把抓取的header写上去就好

同问同问啊~

sinapages每天都有post的新的内容。爬虫很多时候可以抓取到返回的post链接。

mywebdirect、inception、portalmonitor我觉得这三个很好用

mywebdirect可以爬点内容,效果还不错。(需要权限,有点小贵。)inception的效果感觉有点差,但是如果能实现每天定时爬的话效果也不错。portalmonitor的话,如果爬了内容还有爬vid就行。这个还是得权限多。(那个boss什么的权限较多是不可以下的吧?)如果爬了什么新闻和图片,对数据库有要求,最好还是用googleanalytics吧,我最近用的是mongodb和googlesolr。 查看全部

完整的采集神器建议用ffmpeg而不是awkjava已经封装得很好

完整的采集神器建议用ffmpeg而不是awkjava已经封装得很好,charles用户点一下header封装好的一大堆,自己再写写,

比较想知道你是怎么获取scrapy的header,

同问一样遇到这个问题也想知道怎么采集

目前github上在传一个用python来抓包分析的一个工具,可以直接配置抓包参数,也可以自己人肉搜索scrapy的header,同样是python实现,有兴趣的话可以看看。免费开源,完全免费。

用一个叫forwardlibtable的东西,由mit许可证,

header分为http长headers和cookie,后者更适合抓dom的,建议你写一个采集系统,ip,域名,等等。然后自动推送到sina,

我也想请教一下你是怎么成功采集v2ex的

v2ex的hosts把抓取的header写上去就好

同问同问啊~

sinapages每天都有post的新的内容。爬虫很多时候可以抓取到返回的post链接。

mywebdirect、inception、portalmonitor我觉得这三个很好用

mywebdirect可以爬点内容,效果还不错。(需要权限,有点小贵。)inception的效果感觉有点差,但是如果能实现每天定时爬的话效果也不错。portalmonitor的话,如果爬了内容还有爬vid就行。这个还是得权限多。(那个boss什么的权限较多是不可以下的吧?)如果爬了什么新闻和图片,对数据库有要求,最好还是用googleanalytics吧,我最近用的是mongodb和googlesolr。

优采云采集企业版破解版功能功能介绍

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-08-14 07:18

优采云采集企业版破解版功能功能介绍

优采云采集企业版 破解版是一款计算机网络检测工具,软件可以采集网站代码和一切进行编辑,小编带来的破解版可以让你免费使用企业版内容完整,绿色免安装。

软件介绍

这个优采云采集器软件虽然不是最新版本,但是已经完美破解了。非常适合钱包不鼓的SEO用户。它是绿色的,完美地裂开。解压后可以使用企业版7.6 版本。功能齐全。 优采云采集器的主要SEO功能是“本地编辑任务采集数据”功能,但是官方版本是需要购买这个功能才能使用,所以赶紧下载吧!

破解说明

绿色破解企业版,解压后打开LocoyPlatform.exe直接登录。

软件功能优采云采集器可以灵活快速的抓取网页上分散的数据信息,并通过一系列的分析处理,准确地挖掘出需要的数据。 优采云采集器 经过十年的升级更新,积累了大量的用户和良好的口碑。是目前最流行的网页资料采集software。 采集无限网页,无限内容,支持多种扩展,突破操作限制。您决定选择什么以及如何选择它!

软件功能

采集利器

完美采集所有编码格式页面上的任何代码内容,完美复制,采集结果完美排列,显示效果与原站一样,一键完成非常方便。

无人值守

采集编辑工作无需费心呆在电脑前,软件会帮你自动完成,真正做到无人值守,一劳永逸地预先配置,让人们做更重要的事情。

各种发布形式

可以直接登录大多数cms、BBS网站程序进行自动发布。 采集与发布完美结合,一步到位。

本地编辑

可直接编辑编辑的内容,适配布局风格,内置编辑器使用方便,方便您编辑伪原创等内容。

下载地址

免费下载 查看全部

优采云采集企业版破解版功能功能介绍

https://www.juan920.com/wp-con ... 8.png 300w, https://www.juan920.com/wp-con ... 9.png 768w" />

https://www.juan920.com/wp-con ... 8.png 300w, https://www.juan920.com/wp-con ... 9.png 768w" />优采云采集企业版 破解版是一款计算机网络检测工具,软件可以采集网站代码和一切进行编辑,小编带来的破解版可以让你免费使用企业版内容完整,绿色免安装。

软件介绍

这个优采云采集器软件虽然不是最新版本,但是已经完美破解了。非常适合钱包不鼓的SEO用户。它是绿色的,完美地裂开。解压后可以使用企业版7.6 版本。功能齐全。 优采云采集器的主要SEO功能是“本地编辑任务采集数据”功能,但是官方版本是需要购买这个功能才能使用,所以赶紧下载吧!

破解说明

绿色破解企业版,解压后打开LocoyPlatform.exe直接登录。

软件功能优采云采集器可以灵活快速的抓取网页上分散的数据信息,并通过一系列的分析处理,准确地挖掘出需要的数据。 优采云采集器 经过十年的升级更新,积累了大量的用户和良好的口碑。是目前最流行的网页资料采集software。 采集无限网页,无限内容,支持多种扩展,突破操作限制。您决定选择什么以及如何选择它!

软件功能

采集利器

完美采集所有编码格式页面上的任何代码内容,完美复制,采集结果完美排列,显示效果与原站一样,一键完成非常方便。

无人值守

采集编辑工作无需费心呆在电脑前,软件会帮你自动完成,真正做到无人值守,一劳永逸地预先配置,让人们做更重要的事情。

各种发布形式

可以直接登录大多数cms、BBS网站程序进行自动发布。 采集与发布完美结合,一步到位。

本地编辑

可直接编辑编辑的内容,适配布局风格,内置编辑器使用方便,方便您编辑伪原创等内容。

下载地址

免费下载

html网页文字抓取器可以自动获取指定网页上所有文字

采集交流 • 优采云 发表了文章 • 0 个评论 • 320 次浏览 • 2021-08-08 02:22

这是网页文字采集器。 html网页文字抓取器可以自动获取指定网页上的所有文字。比如起点小说网站,一些禁止复制的电子书。适用于所有 html 类型的文本。

软件介绍

网页文字抓取器,又称采集软件,可以自动获取指定网页上的所有文字。它可以突破一些禁止复制的电子书。经过一个简单的设置程序,它就可以工作了。

软件更新

1、增加了连续多页目录和文章的采集功能,所以新版本也将支持论坛主题中的采集。

2、添加批量采集和图片浏览功能

3、增加批量下载文件功能。

4、 增加了多种获取文件名的方式。

5、增加了网页表单数据批量采集功能。

6、URL 菜单增加了全选、反选、取消功能。

7、Browse菜单增加高亮当前网页的指定字符串并打开INTERNET选项控制面板的功能。

8、 文本菜单增加了搜索和搜索下一个功能,插入当前浏览网页的所有显示文字和浏览网页的主要源代码的功能,以及删除收录a的行的功能批量指定字符。

9、增加了对部分网页弹出对话框、广告、图片等的屏蔽功能。

10、根据功能的改进,对界面做了一些改动。

相关介绍

在互联网的信息时代,每天上网的时候,经常会遇到喜欢的文章,或者是小说等等,从一两页到几十页,甚至上百上千页不等,这么多字。复制下载非常麻烦。在记事本和网络浏览器之间频繁切换已经够难过了。现在我面临着需要同时进行数十次或数百次这种无聊的机械动作的需求。有没有更简单、更高效、更省力的方法?

软件截图

查看全部

html网页文字抓取器可以自动获取指定网页上所有文字

这是网页文字采集器。 html网页文字抓取器可以自动获取指定网页上的所有文字。比如起点小说网站,一些禁止复制的电子书。适用于所有 html 类型的文本。

软件介绍

网页文字抓取器,又称采集软件,可以自动获取指定网页上的所有文字。它可以突破一些禁止复制的电子书。经过一个简单的设置程序,它就可以工作了。

软件更新

1、增加了连续多页目录和文章的采集功能,所以新版本也将支持论坛主题中的采集。

2、添加批量采集和图片浏览功能

3、增加批量下载文件功能。

4、 增加了多种获取文件名的方式。

5、增加了网页表单数据批量采集功能。

6、URL 菜单增加了全选、反选、取消功能。

7、Browse菜单增加高亮当前网页的指定字符串并打开INTERNET选项控制面板的功能。

8、 文本菜单增加了搜索和搜索下一个功能,插入当前浏览网页的所有显示文字和浏览网页的主要源代码的功能,以及删除收录a的行的功能批量指定字符。

9、增加了对部分网页弹出对话框、广告、图片等的屏蔽功能。

10、根据功能的改进,对界面做了一些改动。

相关介绍

在互联网的信息时代,每天上网的时候,经常会遇到喜欢的文章,或者是小说等等,从一两页到几十页,甚至上百上千页不等,这么多字。复制下载非常麻烦。在记事本和网络浏览器之间频繁切换已经够难过了。现在我面临着需要同时进行数十次或数百次这种无聊的机械动作的需求。有没有更简单、更高效、更省力的方法?

软件截图

app注册通过openinstall申请app免登陆注册接入,怎么看?

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-08-02 00:03

完整的采集神器不如插件功能全,但是能实现比较高的采集效率采集原理是通过openinstall接入注册机。创建一个采集任务,生成一个独立文件(注册机文件),在appstore发布,

先回答题主的问题,整个请求到底怎么看?从上到下分别是app注册-回复评论,最后到点击分享是通过openinstall上游app的回复实现。app注册通过openinstall申请app免登陆注册接入,可以在海外推广中获得更多精准曝光机会。手机号注册一次可以多个用户一起注册,或者通过企业级认证之后,可以开发者主动获取用户手机号码,比如自己研发某个app,需要多个方便用户注册的手机号码。

用户登陆无论是使用注册机还是手机号码都可以登陆官网,openinstall可以让用户在不注册的情况下快速登陆官网并完成注册。详情见下图为验证注册机注册量以及openinstall助力活动的真实性。回复评论不需要app验证手机,全程不需要注册,点击分享即可到达push消息。最后放几张使用最多的情况,有一定帮助。

用户使用时被分享给某小程序,可以大大提高转化率。微信本身不提供收发评论的权限,需要在接入第三方平台。而接入第三方是通过一个称之为回复评论的注册机来接入。这样通过不同的方式就实现了从app获取评论的机制。如果是传统的平台机制,对于用户使用时被分享给小程序的消息不知道怎么分析,因为没有小程序助手能够直接接收到。

这里要说一下,小程序不是服务号,它是跳过微信群发消息发送的。在注册机上接入回复评论,小程序助手接收到你的评论后会自动跳转到消息群,也不会把评论在自己其他平台分享。然后你就可以在微信群分享评论,或者发朋友圈了。总之获取评论的机制这个是可以实现的。 查看全部

app注册通过openinstall申请app免登陆注册接入,怎么看?

完整的采集神器不如插件功能全,但是能实现比较高的采集效率采集原理是通过openinstall接入注册机。创建一个采集任务,生成一个独立文件(注册机文件),在appstore发布,

先回答题主的问题,整个请求到底怎么看?从上到下分别是app注册-回复评论,最后到点击分享是通过openinstall上游app的回复实现。app注册通过openinstall申请app免登陆注册接入,可以在海外推广中获得更多精准曝光机会。手机号注册一次可以多个用户一起注册,或者通过企业级认证之后,可以开发者主动获取用户手机号码,比如自己研发某个app,需要多个方便用户注册的手机号码。

用户登陆无论是使用注册机还是手机号码都可以登陆官网,openinstall可以让用户在不注册的情况下快速登陆官网并完成注册。详情见下图为验证注册机注册量以及openinstall助力活动的真实性。回复评论不需要app验证手机,全程不需要注册,点击分享即可到达push消息。最后放几张使用最多的情况,有一定帮助。

用户使用时被分享给某小程序,可以大大提高转化率。微信本身不提供收发评论的权限,需要在接入第三方平台。而接入第三方是通过一个称之为回复评论的注册机来接入。这样通过不同的方式就实现了从app获取评论的机制。如果是传统的平台机制,对于用户使用时被分享给小程序的消息不知道怎么分析,因为没有小程序助手能够直接接收到。

这里要说一下,小程序不是服务号,它是跳过微信群发消息发送的。在注册机上接入回复评论,小程序助手接收到你的评论后会自动跳转到消息群,也不会把评论在自己其他平台分享。然后你就可以在微信群分享评论,或者发朋友圈了。总之获取评论的机制这个是可以实现的。

完整的采集神器 “乐器名”“什么乐器”半音阶”(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 161 次浏览 • 2021-07-15 19:02

完整的采集神器,完整采集使用说明采集知乎,需要分好多段落,然后挨个找入口。而我的搜索引擎是以为开启了采集引擎自动抓取列表。我就用页面说明一下吧,本页有“乐器名”“什么乐器”“半音阶”这几个字,我就用了下面这个url(要先解析下request头里的xhrheaders):-for-the-two-drums-in-lenovo-basic-license-series.html/document.getelementbyid("drum-lenovo")上图所示的就是网页中的几处转发入口,其中页面最下方有一个“乐器名”,而正好我用来采集的乐器就是这个乐器。

接下来我们采集说明一下关键问题。首先是点击“乐器名”这一段的时候。我们这里用的是url(不指定其他采集参数)解析方式解析得到的url,也就是关键是我们需要在页面里面插入下面这段脚本:,里面是一段解析脚本。我们如果手动从url中找“什么乐器”这一段:content=url("absolutepublicsite:/t.xxx/")然后再发生任何什么页面的改变,从这里下拉就能找到。

接下来第一个点击的是入口采集时间,接下来我们来看看整个搜索结果页的内容截图:最后我们来看看筛选内容的其他同样的方法采集出来的:-for-two-drums-in-lenovo-basic-license-series.html/document.getelementbyid("filter")&&document.selecteditem.id="filter"filter=icourse.support.lazyrescription:true?然后就可以采集到包括唱片曲目,相关的学术论文等内容的了。下一期采集一下京东的内容,采集教材的内容。 查看全部

完整的采集神器 “乐器名”“什么乐器”半音阶”(图)

完整的采集神器,完整采集使用说明采集知乎,需要分好多段落,然后挨个找入口。而我的搜索引擎是以为开启了采集引擎自动抓取列表。我就用页面说明一下吧,本页有“乐器名”“什么乐器”“半音阶”这几个字,我就用了下面这个url(要先解析下request头里的xhrheaders):-for-the-two-drums-in-lenovo-basic-license-series.html/document.getelementbyid("drum-lenovo")上图所示的就是网页中的几处转发入口,其中页面最下方有一个“乐器名”,而正好我用来采集的乐器就是这个乐器。

接下来我们采集说明一下关键问题。首先是点击“乐器名”这一段的时候。我们这里用的是url(不指定其他采集参数)解析方式解析得到的url,也就是关键是我们需要在页面里面插入下面这段脚本:,里面是一段解析脚本。我们如果手动从url中找“什么乐器”这一段:content=url("absolutepublicsite:/t.xxx/")然后再发生任何什么页面的改变,从这里下拉就能找到。

接下来第一个点击的是入口采集时间,接下来我们来看看整个搜索结果页的内容截图:最后我们来看看筛选内容的其他同样的方法采集出来的:-for-two-drums-in-lenovo-basic-license-series.html/document.getelementbyid("filter")&&document.selecteditem.id="filter"filter=icourse.support.lazyrescription:true?然后就可以采集到包括唱片曲目,相关的学术论文等内容的了。下一期采集一下京东的内容,采集教材的内容。

“数据中台”应运而生,将数据提炼为数据资产

采集交流 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-06-22 02:10

随着数字智能时代的到来,企业需要聚合各个业务领域的数据,并提供强大的中间层,为高频多变的业务场景提供支持。基于这样的需求,“数据中心”应运而生,将数据提炼为数据资产,转化为业务所需的数据“血液”。

数据中心的建设和运营通常包括以下活动:数据聚合、数据处理和提取、对外提供数据服务。其中,数据聚合、数据处理和提炼能力由作为数据中心建设基础的线下开发平台提供。

一、应用场景

例如,某服装企业需要统计过去3个月全国不同城市不同款式服装的销售/库存状况,以指导接下来的销售活动和款式设计。这些数据需要每天更新。这是一个典型的离线计算场景。为完成上述流程,数据部门需要进行以下处理动作:

为了解决以上场景的问题,需要在数据采集、存储、处理等方面进行各种选择比较,通常可以分为以下两类:

1、基于关系型或MPP数据库,如MySQL和Greenplum:

2、基于Hadoop系统的技术方案

3、 以上两类场景存在以下问题:

二、BatchWorks 主要功能

BatchWorks 提供的各种功能完全覆盖了上述场景中的各种需求,收录的功能模块如下:

1、数据同步:

2、数据开发:

3、调度引擎:

4、运维中心:

5、安全保证:

BatchWorks采用多种方式保障数据安全和功能运行安全,主要包括集群安全、数据安全和功能安全三部分:

三、产品优势

1、全生命周期覆盖:

覆盖数据采集、数据处理、调度依赖、任务运维等场景,充分满足离线数据开发流程需求,与传统开源工具相比,可节省80%的数据开发时间。

2、多引擎,异构对接:

3、自主知识产权:2个核心模块100%自主研发,掌握全部知识产权

4、在线,可视化操作:

产品通过网页向用户提供服务,屏蔽底层复杂的分布式计算引擎,开发在线开发平台,提高开发效率。

来自“ITPUB博客”,链接:,如需转载请注明出处,否则将追究法律责任。 查看全部

“数据中台”应运而生,将数据提炼为数据资产

随着数字智能时代的到来,企业需要聚合各个业务领域的数据,并提供强大的中间层,为高频多变的业务场景提供支持。基于这样的需求,“数据中心”应运而生,将数据提炼为数据资产,转化为业务所需的数据“血液”。

数据中心的建设和运营通常包括以下活动:数据聚合、数据处理和提取、对外提供数据服务。其中,数据聚合、数据处理和提炼能力由作为数据中心建设基础的线下开发平台提供。

一、应用场景

例如,某服装企业需要统计过去3个月全国不同城市不同款式服装的销售/库存状况,以指导接下来的销售活动和款式设计。这些数据需要每天更新。这是一个典型的离线计算场景。为完成上述流程,数据部门需要进行以下处理动作:

为了解决以上场景的问题,需要在数据采集、存储、处理等方面进行各种选择比较,通常可以分为以下两类:

1、基于关系型或MPP数据库,如MySQL和Greenplum:

2、基于Hadoop系统的技术方案

3、 以上两类场景存在以下问题:

二、BatchWorks 主要功能

BatchWorks 提供的各种功能完全覆盖了上述场景中的各种需求,收录的功能模块如下:

1、数据同步:

2、数据开发:

3、调度引擎:

4、运维中心:

5、安全保证:

BatchWorks采用多种方式保障数据安全和功能运行安全,主要包括集群安全、数据安全和功能安全三部分:

三、产品优势

1、全生命周期覆盖:

覆盖数据采集、数据处理、调度依赖、任务运维等场景,充分满足离线数据开发流程需求,与传统开源工具相比,可节省80%的数据开发时间。

2、多引擎,异构对接:

3、自主知识产权:2个核心模块100%自主研发,掌握全部知识产权

4、在线,可视化操作:

产品通过网页向用户提供服务,屏蔽底层复杂的分布式计算引擎,开发在线开发平台,提高开发效率。

来自“ITPUB博客”,链接:,如需转载请注明出处,否则将追究法律责任。

完整的采集神器,可以让采集的效率和速度飙升100倍!

采集交流 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-06-14 02:01

完整的采集神器,可以让采集的效率和速度飙升100倍!话不多说,直接上图如需获取完整采集包,

其实我觉得很多人都有自己喜欢的优秀作品,现在外国图片太火了,分享我自己没事会在学校或者上班地方拿来拍的,或者下载也行,毕竟国外的太精美。想下载又不想放上去就麻烦你们了。如何获取?手机端,打开bd图片app,然后把想要的图片,点击进入,如下图:我这里显示只有500张,点击全部,我们可以看到这500张里面,都是有超过500个名额的,很多都没有下载,可能是需要付费等一系列原因。

那么我们这样做就好了,直接去掉水印,放上自己的水印,就可以获取了。还有不少图的,自己去看看哈。如果你们想要就评论吧,也许在评论区能找到你的,真的。评论区自己找了哈,百度云下面也很多,你们自己找哈哈。

欢迎私我,

我上知乎下啥得了,赶紧私信我好吗。

我以前也有过相同的问题。回答如下,如有侵权请删除1-我自己目前还是处于上学的状态,这样就会有人把上学时期学的素材打包成站内清晰视频资源给你,或者直接免费把清晰视频发你,你可以采集。2-推荐一个答主,叫木维禄,他的课有讲关于下载图片ppt文件的,你在他的一个回答下方评论采集图片,他就会回复,你的链接加他,他就会把资源发给你。

3-你可以在微信关注"绿客"公众号,它会推送一个专门做图片的公众号"快传网",里面有很多关于下载图片ppt文件的文章,关注后回复"下载",资源就会给你啦,当然你也可以直接在公众号留言。4-你可以自己去百度,把要下载的图片搜索到,然后点击对应图片进行采集。需要注意的一点是,好像是百度云收费的,虽然下载速度不会有较大影响,但是到百度百科上存有费用的,建议你先付费再进行下载。

最后,可以下一个"gif蛋"app,里面的采集功能会比你在b站的要全面很多,比如你在百度网盘下载了一个动图,之后发到你要做图片的网站上的话,它会自动保存到你百度网盘的文件里。以上可以解决你90%下载问题。 查看全部

完整的采集神器,可以让采集的效率和速度飙升100倍!

完整的采集神器,可以让采集的效率和速度飙升100倍!话不多说,直接上图如需获取完整采集包,

其实我觉得很多人都有自己喜欢的优秀作品,现在外国图片太火了,分享我自己没事会在学校或者上班地方拿来拍的,或者下载也行,毕竟国外的太精美。想下载又不想放上去就麻烦你们了。如何获取?手机端,打开bd图片app,然后把想要的图片,点击进入,如下图:我这里显示只有500张,点击全部,我们可以看到这500张里面,都是有超过500个名额的,很多都没有下载,可能是需要付费等一系列原因。

那么我们这样做就好了,直接去掉水印,放上自己的水印,就可以获取了。还有不少图的,自己去看看哈。如果你们想要就评论吧,也许在评论区能找到你的,真的。评论区自己找了哈,百度云下面也很多,你们自己找哈哈。

欢迎私我,

我上知乎下啥得了,赶紧私信我好吗。

我以前也有过相同的问题。回答如下,如有侵权请删除1-我自己目前还是处于上学的状态,这样就会有人把上学时期学的素材打包成站内清晰视频资源给你,或者直接免费把清晰视频发你,你可以采集。2-推荐一个答主,叫木维禄,他的课有讲关于下载图片ppt文件的,你在他的一个回答下方评论采集图片,他就会回复,你的链接加他,他就会把资源发给你。

3-你可以在微信关注"绿客"公众号,它会推送一个专门做图片的公众号"快传网",里面有很多关于下载图片ppt文件的文章,关注后回复"下载",资源就会给你啦,当然你也可以直接在公众号留言。4-你可以自己去百度,把要下载的图片搜索到,然后点击对应图片进行采集。需要注意的一点是,好像是百度云收费的,虽然下载速度不会有较大影响,但是到百度百科上存有费用的,建议你先付费再进行下载。

最后,可以下一个"gif蛋"app,里面的采集功能会比你在b站的要全面很多,比如你在百度网盘下载了一个动图,之后发到你要做图片的网站上的话,它会自动保存到你百度网盘的文件里。以上可以解决你90%下载问题。

可用php、java等语言实现,不用特别精通技术

采集交流 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-06-12 23:03

完整的采集神器,可在github下载。可用php、java等语言实现,不用特别精通技术,不需要会一门编程语言,知道用它怎么处理数据,神器全靠它每天获取50万数据!espressojs,解决爬虫爬来的数据质量,可以收取用户每笔交易的佣金,

[可持续性方向]可以基于项目来提取,easyrecruit,还有mobashart有各类数据采集的网站,可以放大,也可以加分层存储,模型化存储,

非常推荐推敲条数据爬虫学院推荐,以业务场景(如电商类别,本身业务流水就巨大)以及爬虫数据价值(如用户或商品分析)为目标,可以避免生硬的代码来解决爬虫问题,可以选择api爬虫,

感觉比较python靠谱吧爬虫框架torihb,

数据老大哥talkingdata-talkingdata数据大师

jsoup

阿里在搞一个数据开放平台,对外开放数据,你可以去关注下。

数据采集使用阿里云的云采集就可以解决这个问题

建议题主弄个京东数据相关的,方便数据分析。还有腾讯用户数据其实很好采集的。

你直接从我的个人空间里下这个链接吧【数据开放平台】

如果需要采集宝宝年龄分布的话,现在有接入、京东有接入。 查看全部

可用php、java等语言实现,不用特别精通技术

完整的采集神器,可在github下载。可用php、java等语言实现,不用特别精通技术,不需要会一门编程语言,知道用它怎么处理数据,神器全靠它每天获取50万数据!espressojs,解决爬虫爬来的数据质量,可以收取用户每笔交易的佣金,

[可持续性方向]可以基于项目来提取,easyrecruit,还有mobashart有各类数据采集的网站,可以放大,也可以加分层存储,模型化存储,

非常推荐推敲条数据爬虫学院推荐,以业务场景(如电商类别,本身业务流水就巨大)以及爬虫数据价值(如用户或商品分析)为目标,可以避免生硬的代码来解决爬虫问题,可以选择api爬虫,

感觉比较python靠谱吧爬虫框架torihb,

数据老大哥talkingdata-talkingdata数据大师

jsoup

阿里在搞一个数据开放平台,对外开放数据,你可以去关注下。

数据采集使用阿里云的云采集就可以解决这个问题

建议题主弄个京东数据相关的,方便数据分析。还有腾讯用户数据其实很好采集的。

你直接从我的个人空间里下这个链接吧【数据开放平台】

如果需要采集宝宝年龄分布的话,现在有接入、京东有接入。

完整的采集神器包括十个部分,共耗时一个小时

采集交流 • 优采云 发表了文章 • 0 个评论 • 187 次浏览 • 2021-06-09 18:03

完整的采集神器包括十个部分,共耗时一个小时。其中包括精准元素采集、前端高效提取、采集头图下载、上传采集等采集方法。每一个部分采集方法可以再拆分,逐步实现,形成一个完整的采集神器。下面一步一步对采集方法进行讲解。

一、精准元素采集图片、视频、音频、表格。首先对采集的数据进行筛选,判断数据质量,剔除有问题的,保留正常数据。然后将数据通过爬虫进行提取,(python爬虫即可),分段进行提取。再加上人工排序,为每一段精准元素去重。保证每一段提取数据,既适合放在本机,又适合集群服务器。

三、前端高效提取在刚才完成采集的基础上,通过awk函数对数据进行分块提取。保证每一段提取的数据,都可以放在本机。当然,要提取的值的大小范围,需要根据业务来定义,统一采集默认的当前开发人员接受值(大约1000k)。不需要进行去重,集群服务器中同一条对应的属性值不需要进行重复。比如以前提到的采集头图下载业务,该业务就是awk函数对包含头图的字段采集,保证原始图片的下载。

四、采集头图下载点击鼠标右键,

3)语句,对采集的数据集合进行分割。如分段、返回需要的数据,提取的数据或是不要的数据等。完成分割后,右键采集区域,选择保存文件。若未保存下来,则需要将原来文件内容复制下来。

步骤

1、步骤

2、步骤

3、步骤

4、步骤

5、步骤

6、步骤

7、步骤

8、步骤

9、步骤1

0、步骤1

1、步骤1

2、步骤1

3、步骤1

4、步骤1

5、步骤1

6、步骤1

7、步骤1

8、步骤1

9、步骤2

0、步骤2

1、步骤2

2、步骤2

3、步骤2

4、步骤2

5、步骤2

6、步骤2

7、步骤2

8、步骤2

9、步骤3

0、步骤3

1、步骤3

2、步骤3

3、步骤3

4、步骤3

5、步骤3

6、步骤3

7、步骤3

8、步骤3

9、步骤4

0、步骤4

1、步骤4

2、步骤4

3、步骤4

4、步骤4

5、步骤4

6、步骤4

7、步骤4

8、步骤4

9、步骤5

0、步骤5

1、步骤5

2、步骤5

3、步骤5

4、步骤5

5、步骤5

6、步骤5

7、步骤5

8、步骤5

9、步骤6

0、步骤6

1、步骤6

2、步骤6

3、步骤6

4、步骤6

5、步骤6

6、步骤6

7、步骤6

8、步骤6

9、步骤7

0、步骤7

1、步骤7

2、步骤7

3、步骤7

4、步骤7

5、步骤7

6、步骤7

7、步骤7

8、步骤7

9、步骤8

0、步骤8

2、步骤8

3、步骤8

4、步骤8

5、步骤8

6、步骤8

7、步骤8

8、步骤8

9、步骤9

0、步骤9

1、步骤9

2、步骤9

3、步骤9

4、步骤9

5、步骤9

6、步骤9

7、步骤9

8、步骤9

9、步骤10

0、步骤10

0、步 查看全部

完整的采集神器包括十个部分,共耗时一个小时

完整的采集神器包括十个部分,共耗时一个小时。其中包括精准元素采集、前端高效提取、采集头图下载、上传采集等采集方法。每一个部分采集方法可以再拆分,逐步实现,形成一个完整的采集神器。下面一步一步对采集方法进行讲解。

一、精准元素采集图片、视频、音频、表格。首先对采集的数据进行筛选,判断数据质量,剔除有问题的,保留正常数据。然后将数据通过爬虫进行提取,(python爬虫即可),分段进行提取。再加上人工排序,为每一段精准元素去重。保证每一段提取数据,既适合放在本机,又适合集群服务器。

三、前端高效提取在刚才完成采集的基础上,通过awk函数对数据进行分块提取。保证每一段提取的数据,都可以放在本机。当然,要提取的值的大小范围,需要根据业务来定义,统一采集默认的当前开发人员接受值(大约1000k)。不需要进行去重,集群服务器中同一条对应的属性值不需要进行重复。比如以前提到的采集头图下载业务,该业务就是awk函数对包含头图的字段采集,保证原始图片的下载。

四、采集头图下载点击鼠标右键,

3)语句,对采集的数据集合进行分割。如分段、返回需要的数据,提取的数据或是不要的数据等。完成分割后,右键采集区域,选择保存文件。若未保存下来,则需要将原来文件内容复制下来。

步骤

1、步骤

2、步骤

3、步骤

4、步骤

5、步骤

6、步骤

7、步骤

8、步骤

9、步骤1

0、步骤1

1、步骤1

2、步骤1

3、步骤1

4、步骤1

5、步骤1

6、步骤1

7、步骤1

8、步骤1

9、步骤2

0、步骤2

1、步骤2

2、步骤2

3、步骤2

4、步骤2

5、步骤2

6、步骤2

7、步骤2

8、步骤2

9、步骤3

0、步骤3

1、步骤3

2、步骤3

3、步骤3

4、步骤3

5、步骤3

6、步骤3

7、步骤3

8、步骤3

9、步骤4

0、步骤4

1、步骤4

2、步骤4

3、步骤4

4、步骤4

5、步骤4

6、步骤4

7、步骤4

8、步骤4

9、步骤5

0、步骤5

1、步骤5

2、步骤5

3、步骤5

4、步骤5

5、步骤5

6、步骤5

7、步骤5

8、步骤5

9、步骤6

0、步骤6

1、步骤6

2、步骤6

3、步骤6

4、步骤6

5、步骤6

6、步骤6

7、步骤6

8、步骤6

9、步骤7

0、步骤7

1、步骤7

2、步骤7

3、步骤7

4、步骤7

5、步骤7

6、步骤7

7、步骤7

8、步骤7

9、步骤8

0、步骤8

2、步骤8

3、步骤8

4、步骤8

5、步骤8

6、步骤8

7、步骤8

8、步骤8

9、步骤9

0、步骤9

1、步骤9

2、步骤9

3、步骤9

4、步骤9

5、步骤9

6、步骤9

7、步骤9

8、步骤9

9、步骤10

0、步骤10

0、步

完整的采集神器路径在这,能采集70多个平台

采集交流 • 优采云 发表了文章 • 0 个评论 • 176 次浏览 • 2021-06-08 05:01

完整的采集神器路径在这,能采集70多个平台,更多的请看下面:内涵图是一个自媒体平台,我们从那内容可以挖掘出来就自己运营吧,不要纠结平台的问题。很多大咖都发表过内涵图,我自己会在喜马拉雅平台上,关注节目进行学习,各大平台都是最新出的内容,自己发表就是追热点,提高自己的曝光度。自媒体图片不要违规,不然会被封号的,不要告诉我怎么采集,目前来看自媒体采集是违规的,自己做就完了,什么平台都是能采集的。

现在自媒体收益比较微薄,再不抓紧时间自媒体收益更微薄了。内涵图收益非常薄,自己做都是自己辛苦赚的,平台分不到多少钱。目前自媒体收益比较好的平台就是今日头条、企鹅号、大鱼号,收益算是比较可观的了,尤其是企鹅号现在单价还是很高的,阅读才一块多一块,月入上万很轻松。转正以后大概单价就在2块多一块。企鹅号指数越高,单价越高,一百万的阅读单价才二三十块钱,自己做的单价可以适当降低一点。

自媒体爆文的文章怎么才能火起来?这里也有采集和伪原创的技巧和技巧,单靠写优质的原创内容在自媒体平台一文不出绝对是火不起来的,大多数情况都是标题党或者是抄袭,一定要注意。下面附上自媒体收益单价图:目前每天的自媒体收益都差不多,100块钱左右,这个单价对于一个新手来说已经足够了,可以说一月赚个5000没问题,前提是前面写对一个平台,这样自己赚的利润比较高。

这只是月收益,除去扣掉税金、工资、我们平时买东西或者买衣服时候,购物车里需要剁手的花费。其实每天这100块钱自己也不少了,不算少,我算这里的自媒体人都会“微商”,他们经常做一些推广、玩一些免费的流量,其实前期的10块钱也是钱,这些算在自己身上,没错,他们确实赚钱,而且年收益大多在10000以上,而我们还在苦苦寻找方法来赚取这一点点小钱。 查看全部

完整的采集神器路径在这,能采集70多个平台

完整的采集神器路径在这,能采集70多个平台,更多的请看下面:内涵图是一个自媒体平台,我们从那内容可以挖掘出来就自己运营吧,不要纠结平台的问题。很多大咖都发表过内涵图,我自己会在喜马拉雅平台上,关注节目进行学习,各大平台都是最新出的内容,自己发表就是追热点,提高自己的曝光度。自媒体图片不要违规,不然会被封号的,不要告诉我怎么采集,目前来看自媒体采集是违规的,自己做就完了,什么平台都是能采集的。

现在自媒体收益比较微薄,再不抓紧时间自媒体收益更微薄了。内涵图收益非常薄,自己做都是自己辛苦赚的,平台分不到多少钱。目前自媒体收益比较好的平台就是今日头条、企鹅号、大鱼号,收益算是比较可观的了,尤其是企鹅号现在单价还是很高的,阅读才一块多一块,月入上万很轻松。转正以后大概单价就在2块多一块。企鹅号指数越高,单价越高,一百万的阅读单价才二三十块钱,自己做的单价可以适当降低一点。

自媒体爆文的文章怎么才能火起来?这里也有采集和伪原创的技巧和技巧,单靠写优质的原创内容在自媒体平台一文不出绝对是火不起来的,大多数情况都是标题党或者是抄袭,一定要注意。下面附上自媒体收益单价图:目前每天的自媒体收益都差不多,100块钱左右,这个单价对于一个新手来说已经足够了,可以说一月赚个5000没问题,前提是前面写对一个平台,这样自己赚的利润比较高。

这只是月收益,除去扣掉税金、工资、我们平时买东西或者买衣服时候,购物车里需要剁手的花费。其实每天这100块钱自己也不少了,不算少,我算这里的自媒体人都会“微商”,他们经常做一些推广、玩一些免费的流量,其实前期的10块钱也是钱,这些算在自己身上,没错,他们确实赚钱,而且年收益大多在10000以上,而我们还在苦苦寻找方法来赚取这一点点小钱。

推荐我用过的采集神器-爬虫网页数据采集网页

采集交流 • 优采云 发表了文章 • 0 个评论 • 182 次浏览 • 2021-06-05 21:02

完整的采集神器有很多,比如chrome里的openfilter,firefox里的firebug,phantomjs等等,这些采集工具通常都有开源版本,但是我发现很多人还是仅限于采集google、百度等第三方页面,这其实是很低级的采集姿势。以上所列工具相当于做了个爬虫,采集的是上传后的页面,采集下来之后如果不过html、css等数据,有些人还是不知道这些页面存在,或者需要给开发者提供数据。

难道这些页面都不存在吗?我们今天介绍一个采集市场上商品详情页的chrome插件strous,它可以采集商品详情页等各个页面内容,浏览器会给你打开全屏的内容,并且随着采集页面数的增加和下载量的增多,页面体积会越来越大,上传原始图片时可能会提示视频超大,这个时候就需要选择图片压缩,或者手动压缩,都有比较折腾。

整个页面采集完成后,我们还可以和编辑器链接起来,给编辑器编辑数据。不过我对其他采集软件已经很熟悉了,就不多做介绍了。大家可以在v2ex、alexa、站长工具等第三方平台和论坛里多多交流,也可以扫描下面二维码加入微信群,了解更多采集的知识。-kex6l5rqofhrtu(二维码自动识别)。

推荐我用过的采集神器:推荐采集神器--爬虫网页数据采集器

采集网页的利器——采集猫,可以用来采集、京东等电商网站的商品信息。而且采集猫在用户体验方面做的十分的不错,把操作流程缩短了,不需要再像旧版采集猫一样对整个网站进行鼠标操作。首先,打开采集猫,选择商品——,将所要采集的商品链接一键点击即可实现采集。按理说,对于每个商品也就能搜索7、8个商品信息,对于需要几十个商品信息的情况有点不现实,而采集猫会自动更新商品信息,再也不用担心在找商品的时候卡图了。

采集猫自带一个采集功能,导航菜单能够给你提供几十个主要页面的商品信息采集,对于不知道找哪个商品的时候,直接点击导航菜单就可以了。采集猫支持主流搜索引擎,在官网能够找到,对于爬虫来说已经够用了。采集猫还会将采集到的数据自动导出到电脑本地,避免重复导出数据。同时支持导出到excel、ppt、html5文件等各种格式。

对于采集猫没有提供的搜索功能,也能够选择提供,有时候让你只需要找几个商品就能够快速找到想要的信息。采集猫还支持发布收藏夹,有不同地方要找数据的时候,数据都能直接在收藏夹里导出。不足的地方就是采集猫上传是全屏的,比较费眼睛,有些细节处理的不是很好。不过,采集猫是免费使用的,刚刚注册的注册客户无需注册就能够免费使用15天。感兴趣的可以去注册一个试试,毕竟公众号回复采集猫获取下。 查看全部

推荐我用过的采集神器-爬虫网页数据采集网页

完整的采集神器有很多,比如chrome里的openfilter,firefox里的firebug,phantomjs等等,这些采集工具通常都有开源版本,但是我发现很多人还是仅限于采集google、百度等第三方页面,这其实是很低级的采集姿势。以上所列工具相当于做了个爬虫,采集的是上传后的页面,采集下来之后如果不过html、css等数据,有些人还是不知道这些页面存在,或者需要给开发者提供数据。

难道这些页面都不存在吗?我们今天介绍一个采集市场上商品详情页的chrome插件strous,它可以采集商品详情页等各个页面内容,浏览器会给你打开全屏的内容,并且随着采集页面数的增加和下载量的增多,页面体积会越来越大,上传原始图片时可能会提示视频超大,这个时候就需要选择图片压缩,或者手动压缩,都有比较折腾。

整个页面采集完成后,我们还可以和编辑器链接起来,给编辑器编辑数据。不过我对其他采集软件已经很熟悉了,就不多做介绍了。大家可以在v2ex、alexa、站长工具等第三方平台和论坛里多多交流,也可以扫描下面二维码加入微信群,了解更多采集的知识。-kex6l5rqofhrtu(二维码自动识别)。

推荐我用过的采集神器:推荐采集神器--爬虫网页数据采集器

采集网页的利器——采集猫,可以用来采集、京东等电商网站的商品信息。而且采集猫在用户体验方面做的十分的不错,把操作流程缩短了,不需要再像旧版采集猫一样对整个网站进行鼠标操作。首先,打开采集猫,选择商品——,将所要采集的商品链接一键点击即可实现采集。按理说,对于每个商品也就能搜索7、8个商品信息,对于需要几十个商品信息的情况有点不现实,而采集猫会自动更新商品信息,再也不用担心在找商品的时候卡图了。

采集猫自带一个采集功能,导航菜单能够给你提供几十个主要页面的商品信息采集,对于不知道找哪个商品的时候,直接点击导航菜单就可以了。采集猫支持主流搜索引擎,在官网能够找到,对于爬虫来说已经够用了。采集猫还会将采集到的数据自动导出到电脑本地,避免重复导出数据。同时支持导出到excel、ppt、html5文件等各种格式。

对于采集猫没有提供的搜索功能,也能够选择提供,有时候让你只需要找几个商品就能够快速找到想要的信息。采集猫还支持发布收藏夹,有不同地方要找数据的时候,数据都能直接在收藏夹里导出。不足的地方就是采集猫上传是全屏的,比较费眼睛,有些细节处理的不是很好。不过,采集猫是免费使用的,刚刚注册的注册客户无需注册就能够免费使用15天。感兴趣的可以去注册一个试试,毕竟公众号回复采集猫获取下。

完整的采集神器——共享代码解决很多没有代码的问题

采集交流 • 优采云 发表了文章 • 0 个评论 • 233 次浏览 • 2021-05-26 21:02

完整的采集神器这里就简单讲一下:默认采集:各大主流平台首页、热门内容、专栏文章、热点新闻,提取的信息也是比较多,可以说是多种类型的信息。整体算是比较全的。ps:插入锚文本就可以导出excel数据。脚本采集:就是使用脚本工具,配合sql注入,可以采集的信息更多,可以采集到关键词的所有内容。除此之外,社区里也有很多好用的脚本工具。

思维导图工具:通过将搜索到的内容进行拆分,把大的分为几个小板块,然后进行思维导图的编辑,将相同的内容汇总到一起。保留原有的页面,更加便于理解和使用。合并词:搜索完,需要查找相同的关键词,思维导图将合并关键词汇总到一起。提取表格信息:合并一整张表格后,可以直接把表格数据导出excel或者pdf。文章翻译:通过对网站进行翻译,把网站的文章,翻译成各国语言,实现跨语言的无缝对接。

知乎答案修改:可以把知乎答案修改到同一个网站,修改网站用语就可以保留原有的网站用语。excel解密:把网站用sql注入密码进行解密,就可以解密ip等信息。网页截图:通过在浏览器搜索图片,浏览后,浏览器会出现一个缩略图,点击缩略图上方的对话框,点击网页截图就可以完成图片的截图。selenium:利用selenium可以将采集的数据交互显示到浏览器上。

可以通过翻页以及鼠标滑动鼠标滚轮的方式交互。共享代码:共享代码解决很多没有代码的问题,就像开发一个外语软件,没有单词的拼写,没有语法的规则,这个怎么办呢?共享代码就是帮助开发者进行这种情况的解决。通过大家一起修改,也可以搞定外语知识。录屏工具:通过鼠标滑动来录制屏幕,发送到剪贴板,下次可以使用了。扫描二维码工具:通过扫描二维码可以识别二维码,无需下载app,最大的优点就是不需要下载app,缺点就是二维码会变形,然后看起来很别扭。

cookie管理工具:不要说你会在哪里登录,打开就可以登录,但是怎么把这个登录的网站保存在自己的帐号里面呢?通过在登录的网站上设置cookie信息,但是这样也存在一个弊端,就是无法保存网站上的内容,也就是说这个内容并不是你的。整个采集的过程需要你自己安装好相应的工具,或者对数据库进行开发。编码工具:采集的数据后面需要采用什么语言,需要进行编码。

数据的清洗与转化:数据的清洗的工作还算是比较简单,用到的技术也有电脑软件的基本操作,数据库的开发,经过前面几个步骤,相信你的数据已经很完整了。数据转化有很多方法,上面列举的都可以转化为方便电脑、手机使用的数据,整个来说,基本原理就是采集数。 查看全部

完整的采集神器——共享代码解决很多没有代码的问题

完整的采集神器这里就简单讲一下:默认采集:各大主流平台首页、热门内容、专栏文章、热点新闻,提取的信息也是比较多,可以说是多种类型的信息。整体算是比较全的。ps:插入锚文本就可以导出excel数据。脚本采集:就是使用脚本工具,配合sql注入,可以采集的信息更多,可以采集到关键词的所有内容。除此之外,社区里也有很多好用的脚本工具。

思维导图工具:通过将搜索到的内容进行拆分,把大的分为几个小板块,然后进行思维导图的编辑,将相同的内容汇总到一起。保留原有的页面,更加便于理解和使用。合并词:搜索完,需要查找相同的关键词,思维导图将合并关键词汇总到一起。提取表格信息:合并一整张表格后,可以直接把表格数据导出excel或者pdf。文章翻译:通过对网站进行翻译,把网站的文章,翻译成各国语言,实现跨语言的无缝对接。

知乎答案修改:可以把知乎答案修改到同一个网站,修改网站用语就可以保留原有的网站用语。excel解密:把网站用sql注入密码进行解密,就可以解密ip等信息。网页截图:通过在浏览器搜索图片,浏览后,浏览器会出现一个缩略图,点击缩略图上方的对话框,点击网页截图就可以完成图片的截图。selenium:利用selenium可以将采集的数据交互显示到浏览器上。

可以通过翻页以及鼠标滑动鼠标滚轮的方式交互。共享代码:共享代码解决很多没有代码的问题,就像开发一个外语软件,没有单词的拼写,没有语法的规则,这个怎么办呢?共享代码就是帮助开发者进行这种情况的解决。通过大家一起修改,也可以搞定外语知识。录屏工具:通过鼠标滑动来录制屏幕,发送到剪贴板,下次可以使用了。扫描二维码工具:通过扫描二维码可以识别二维码,无需下载app,最大的优点就是不需要下载app,缺点就是二维码会变形,然后看起来很别扭。

cookie管理工具:不要说你会在哪里登录,打开就可以登录,但是怎么把这个登录的网站保存在自己的帐号里面呢?通过在登录的网站上设置cookie信息,但是这样也存在一个弊端,就是无法保存网站上的内容,也就是说这个内容并不是你的。整个采集的过程需要你自己安装好相应的工具,或者对数据库进行开发。编码工具:采集的数据后面需要采用什么语言,需要进行编码。

数据的清洗与转化:数据的清洗的工作还算是比较简单,用到的技术也有电脑软件的基本操作,数据库的开发,经过前面几个步骤,相信你的数据已经很完整了。数据转化有很多方法,上面列举的都可以转化为方便电脑、手机使用的数据,整个来说,基本原理就是采集数。

完整的采集神器(如何利用神器Firebug获取远程链接数据的方法?(上))

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-09-02 14:10

对于做过数据采集的人来说,curl一定会很熟悉。 PHP中虽然有file_get_contents函数可以获取远程链接数据,但是可控性太差。对于采集场景的各种复杂情况,file_get_contents似乎有点无能为力。因此,本文将向您介绍采集神器cURL。

首先添加file_get_contents函数获取远程链接数据的方法。

这段代码会直接使用curl来显示文件内容,但是问题来了,因为curl是PHP的一个扩展,有些主机为了安全会使用curl,在本地调试的时候curl也是关闭的宁外PHP,所以会出现错误,所以这段代码不可取,所以云落给他重写了

修改后的版本是对curl扩展做一个判断,看curl扩展是否在服务器上打开。如果打开,则直接显示文件,如果未打开,则显示提示文本。

虽然问题已解决,但还有一个问题。我只显示一段文字。我不做大事,为什么要写这么多代码? ?

经过一些傻测试,我发现file_get_contents获取远程文件内容的速度并不比curl慢,而且在一些文件较少的情况下可能比curl扩展快很多,所以我又重新写了一遍代码

工具

火狐 + 萤火虫

“工人要想做好自己的工作,就必须磨砺他们的工具。”在分析案例之前,让我们学习一下如何使用神器Firebug来获取我们需要的信息。

使用F12打开Firebug,我们可以得到图片(一)interface:

1、箭头图标是“元素选择”工具。单击一次以突出显示该图标。同时,鼠标在页面内的移动会同时选中HTML菜单中的相应内容。此时点击内容表示该元素被选中,图标高亮取消。如图(二):

萤火虫视图元素

2、控制面板

这里输出的是JS中console.log系列函数的打印

3、HTML

HTML 内容,注意这里看到的不一定是采集 想要解析的。对采集处内容的分析总是靠查看源码(Ctrl+U),这里只是可以快速定位的元素结构,然后选择一个比较特殊的引用,在源码中定位到对应的位置代码。

例如,如果您在 HTML 中看到一个标签

演示

,但是你查看源代码看到的可能是

演示

如果使用前者对采集内容进行正则匹配,则不会得到任何结果。

4、CSS

这里是CSS文件的内容

5、Script

这里是Javascript文件的内容

6、DOM

Dom 节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的。它可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求的内容保留在控制台中,如图(三):

此外,Firefox 还有一个 Tamper 数据扩展,也可以获取请求数据,需要时可以安装使用。

8、Cookies

Cookie 数据

图中(一),你也可以看到下面有很多可选的小菜单项,其中keep是我们要注意的。选择时,即使页面被刷新提交表单,下方内容区的数据仍会保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集请求的时候,主要关心的是“Network”菜单中的请求数据。如有必要,使用“Keep”查看刷新页面的请求数据。您可以在请求前使用“清除”清除以下内容。 .

案例分析

一、简的采集

这里简单的采集指的是采集单页GET请求。如此简单,即使通过file_get_contents函数也能轻松获取页面返回结果。

File_get_contents 代码片段

<p> 查看全部

完整的采集神器(如何利用神器Firebug获取远程链接数据的方法?(上))

对于做过数据采集的人来说,curl一定会很熟悉。 PHP中虽然有file_get_contents函数可以获取远程链接数据,但是可控性太差。对于采集场景的各种复杂情况,file_get_contents似乎有点无能为力。因此,本文将向您介绍采集神器cURL。

首先添加file_get_contents函数获取远程链接数据的方法。

这段代码会直接使用curl来显示文件内容,但是问题来了,因为curl是PHP的一个扩展,有些主机为了安全会使用curl,在本地调试的时候curl也是关闭的宁外PHP,所以会出现错误,所以这段代码不可取,所以云落给他重写了

修改后的版本是对curl扩展做一个判断,看curl扩展是否在服务器上打开。如果打开,则直接显示文件,如果未打开,则显示提示文本。

虽然问题已解决,但还有一个问题。我只显示一段文字。我不做大事,为什么要写这么多代码? ?

经过一些傻测试,我发现file_get_contents获取远程文件内容的速度并不比curl慢,而且在一些文件较少的情况下可能比curl扩展快很多,所以我又重新写了一遍代码

工具

火狐 + 萤火虫

“工人要想做好自己的工作,就必须磨砺他们的工具。”在分析案例之前,让我们学习一下如何使用神器Firebug来获取我们需要的信息。

使用F12打开Firebug,我们可以得到图片(一)interface:

1、箭头图标是“元素选择”工具。单击一次以突出显示该图标。同时,鼠标在页面内的移动会同时选中HTML菜单中的相应内容。此时点击内容表示该元素被选中,图标高亮取消。如图(二):

萤火虫视图元素

2、控制面板

这里输出的是JS中console.log系列函数的打印

3、HTML

HTML 内容,注意这里看到的不一定是采集 想要解析的。对采集处内容的分析总是靠查看源码(Ctrl+U),这里只是可以快速定位的元素结构,然后选择一个比较特殊的引用,在源码中定位到对应的位置代码。

例如,如果您在 HTML 中看到一个标签

演示

,但是你查看源代码看到的可能是

演示

如果使用前者对采集内容进行正则匹配,则不会得到任何结果。

4、CSS

这里是CSS文件的内容

5、Script

这里是Javascript文件的内容

6、DOM

Dom 节点内容

7、网络

每个请求链接的数据,这里是我们采集要重点分析的。它可以显示每个请求的参数、请求头、cookie数据等。在页面提交会刷新的情况下,需要使用hold,这样刷新后页面请求的内容保留在控制台中,如图(三):

此外,Firefox 还有一个 Tamper 数据扩展,也可以获取请求数据,需要时可以安装使用。

8、Cookies

Cookie 数据

图中(一),你也可以看到下面有很多可选的小菜单项,其中keep是我们要注意的。选择时,即使页面被刷新提交表单,下方内容区的数据仍会保留,这对于分析提交的数据尤为关键。

总结

我们在分析采集请求的时候,主要关心的是“Network”菜单中的请求数据。如有必要,使用“Keep”查看刷新页面的请求数据。您可以在请求前使用“清除”清除以下内容。 .

案例分析

一、简的采集

这里简单的采集指的是采集单页GET请求。如此简单,即使通过file_get_contents函数也能轻松获取页面返回结果。

File_get_contents 代码片段

<p>

完整的采集神器(如何使用优采云采集进行搜索?写作推出智能采集工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-08-28 13:10

疫情期间,很多企业不得不选择远程在线办公。互联网是受疫情影响较小的行业之一。然而,远程办公仍然没有面对面工作那么高效。出于这个原因优采云采集专利权采集tools。

相信很多运营商都接触过采集tools。现在市场上有很多种采集tools。很多人认为采集工具只是文章hot/festival 话题等信息采集 的辅助工具,其实不仅如此。一个成熟的采集工具,不仅是帮助运营采集信息,更要精准分析数据趋势,帮助增加收益。

一、什么是优采云采集?

优采云采集是自媒体材料搜、文章原创的运营工具,一键发布,有效提高新媒体运营效率,降低企业成本。

二、如何使用优采云采集进行搜索?

(一)输入关键词

优采云采集 根据用户输入的关键词,搜索引擎通过程序自动进入主流自媒体数据源。

优采云采集基于高级算法匹配更准确的内容,提高搜索内容的准确性。

例如:

用户需要采集与疫情相关的资料,在主页输入关键词“流行病”。 优采云采集 会将搜索结果整合到一个列表中。

(二)保存搜索资料

优采云采集具有批量保存搜索资料的功能。

点击【全选当前页】功能,勾选需要的文章,文章会添加到操作面板中,方便用户批量保存。

(三)精准过滤

1、搜索过滤器

优采云采集支持根据标题、内容、时间、平台、是否原创等参数进行过滤,使搜索内容更加准确。

2、广告过滤 查看全部

完整的采集神器(如何使用优采云采集进行搜索?写作推出智能采集工具)

疫情期间,很多企业不得不选择远程在线办公。互联网是受疫情影响较小的行业之一。然而,远程办公仍然没有面对面工作那么高效。出于这个原因优采云采集专利权采集tools。

相信很多运营商都接触过采集tools。现在市场上有很多种采集tools。很多人认为采集工具只是文章hot/festival 话题等信息采集 的辅助工具,其实不仅如此。一个成熟的采集工具,不仅是帮助运营采集信息,更要精准分析数据趋势,帮助增加收益。

一、什么是优采云采集?

优采云采集是自媒体材料搜、文章原创的运营工具,一键发布,有效提高新媒体运营效率,降低企业成本。

二、如何使用优采云采集进行搜索?

(一)输入关键词

优采云采集 根据用户输入的关键词,搜索引擎通过程序自动进入主流自媒体数据源。

优采云采集基于高级算法匹配更准确的内容,提高搜索内容的准确性。

例如:

用户需要采集与疫情相关的资料,在主页输入关键词“流行病”。 优采云采集 会将搜索结果整合到一个列表中。

(二)保存搜索资料

优采云采集具有批量保存搜索资料的功能。

点击【全选当前页】功能,勾选需要的文章,文章会添加到操作面板中,方便用户批量保存。

(三)精准过滤

1、搜索过滤器

优采云采集支持根据标题、内容、时间、平台、是否原创等参数进行过滤,使搜索内容更加准确。

2、广告过滤

完整的采集神器(本文介绍如何采集网站上多关键词的流程图模式?介绍 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 184 次浏览 • 2021-08-28 10:11

)

本文介绍如何使用优采云采集器的流程图模式,并介绍如何采集网站上多关键词。

第一步:新建采集task

1、复制官网网址(需要搜索结果页面的网址,不是首页的网址)

点击此处了解如何正确输入网址。

2、新流程图模式采集task

可以直接在软件上创建采集任务,也可以通过导入规则来创建任务。

单击此处了解如何导入和导出采集 规则。

第二步:配置采集规则

1、设置多个关键字循环任务

流程图模式下输入创建新任务的URL后,我们点击搜索框,然后在左上角出现的操作提示框中输入采集的文字。

单击此处了解有关输入文本组件的更多信息。

由于需要输入多个关键词数据,我们选择点击操作框上的批量输入文本按钮。

然后选择批量输入单个文本。

然后在弹出的文本列表中输入我们需要设置的文本,这里我们输入“设置”、“采集”、“数据”关键词。

点击“确定”按钮后,软件会自动生成一个圆形的关键词列表。

然后我们点击页面上的搜索按钮,在操作框中选择“点击该元素一次”按钮,跳转到搜索结果页面。

2、设置提取字段数据

输入多个关键字并设置循环后,我们设置需要提取的字段数据,点击网页上的字段,在左上角的操作提示框中选择提取所有元素。然后软件会自动识别分页,用户根据软件提示设置分页。

然后我们可以在此基础上设置采集字段,用户可以根据自己的需要进行设置。

更多详情,请参考以下教程:

如何配置采集字段

3、深入设置采集

如果需要采集detail页面的数据,可以使用deep采集函数。

更多详情,请参考以下教程:

如何实现深入采集

4、设置详情页数据

详情页的采集与单页类型的采集相同。我们点击页面上需要采集的数据,然后点击操作提示框中的“从此元素中提取数据”按钮,数据设置可以参考列表页上的设置。

更多详情,请参考以下教程:

如何采集单页类型网页

5、完整的组件图

第三步:设置并启动采集task

1、START采集task

点击“Start采集”按钮,可以在弹出的启动设置页面进行一些高级设置,包括“定时启动、防阻塞、自动导出、文件下载、加速引擎、重复数据删除、开发者settings”功能,本次操作不使用以上功能,直接点击开始按钮启动采集即可。

单击此处了解有关预定开始时间的更多信息。

单击此处了解有关自动导出的更多信息。

单击此处了解有关如何下载图片的更多信息。

【温馨提示】免费版可以使用非周期性定时采集功能,下载图片功能免费;专业版及以上用户可以使用定时启动功能;旗舰版用户可以使用自动导出功能和加速引擎功能。

2、运行任务提取数据

任务启动后,采集数据会自动启动。从界面上我们可以直观的看到程序运行的过程和采集的结果。 采集结束后会有提醒。

第 4 步:导出和查看数据

data采集完成后,我们就可以查看和导出数据了。 优采云采集器支持多种导出方式(手动导出到本地、手动导出到数据库、自动发布到数据库、自动发布到网站)以及导出文件的格式(EXCEL、CSV、HTML和TXT)。它还支持导出特定数量的项目。您可以在数据中选择要导出的项目数,然后点击“确认导出”。

查看全部

完整的采集神器(本文介绍如何采集网站上多关键词的流程图模式?介绍

)

本文介绍如何使用优采云采集器的流程图模式,并介绍如何采集网站上多关键词。

第一步:新建采集task

1、复制官网网址(需要搜索结果页面的网址,不是首页的网址)

点击此处了解如何正确输入网址。

2、新流程图模式采集task

可以直接在软件上创建采集任务,也可以通过导入规则来创建任务。

单击此处了解如何导入和导出采集 规则。

第二步:配置采集规则

1、设置多个关键字循环任务

流程图模式下输入创建新任务的URL后,我们点击搜索框,然后在左上角出现的操作提示框中输入采集的文字。

单击此处了解有关输入文本组件的更多信息。

由于需要输入多个关键词数据,我们选择点击操作框上的批量输入文本按钮。

然后选择批量输入单个文本。

然后在弹出的文本列表中输入我们需要设置的文本,这里我们输入“设置”、“采集”、“数据”关键词。

点击“确定”按钮后,软件会自动生成一个圆形的关键词列表。

然后我们点击页面上的搜索按钮,在操作框中选择“点击该元素一次”按钮,跳转到搜索结果页面。

2、设置提取字段数据

输入多个关键字并设置循环后,我们设置需要提取的字段数据,点击网页上的字段,在左上角的操作提示框中选择提取所有元素。然后软件会自动识别分页,用户根据软件提示设置分页。

然后我们可以在此基础上设置采集字段,用户可以根据自己的需要进行设置。

更多详情,请参考以下教程:

如何配置采集字段

3、深入设置采集

如果需要采集detail页面的数据,可以使用deep采集函数。

更多详情,请参考以下教程:

如何实现深入采集

4、设置详情页数据

详情页的采集与单页类型的采集相同。我们点击页面上需要采集的数据,然后点击操作提示框中的“从此元素中提取数据”按钮,数据设置可以参考列表页上的设置。

更多详情,请参考以下教程:

如何采集单页类型网页

5、完整的组件图

第三步:设置并启动采集task

1、START采集task

点击“Start采集”按钮,可以在弹出的启动设置页面进行一些高级设置,包括“定时启动、防阻塞、自动导出、文件下载、加速引擎、重复数据删除、开发者settings”功能,本次操作不使用以上功能,直接点击开始按钮启动采集即可。

单击此处了解有关预定开始时间的更多信息。

单击此处了解有关自动导出的更多信息。

单击此处了解有关如何下载图片的更多信息。

【温馨提示】免费版可以使用非周期性定时采集功能,下载图片功能免费;专业版及以上用户可以使用定时启动功能;旗舰版用户可以使用自动导出功能和加速引擎功能。

2、运行任务提取数据

任务启动后,采集数据会自动启动。从界面上我们可以直观的看到程序运行的过程和采集的结果。 采集结束后会有提醒。

第 4 步:导出和查看数据

data采集完成后,我们就可以查看和导出数据了。 优采云采集器支持多种导出方式(手动导出到本地、手动导出到数据库、自动发布到数据库、自动发布到网站)以及导出文件的格式(EXCEL、CSV、HTML和TXT)。它还支持导出特定数量的项目。您可以在数据中选择要导出的项目数,然后点击“确认导出”。

完整的采集神器,让你开启动态抓取神器!(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 149 次浏览 • 2021-08-27 18:07

完整的采集神器百度很早就有。自己f12再加flashsnippet,不断模拟鼠标点击点击。很多功能是现成的,爬虫其实每个ui点两下,剩下操作flash就行了,

整站采集神器:采集派采集派,采集速度超快的采集神器,让你开启动态抓取神器!

你可以试试尝试参照这个:如何快速获取api的脚本?-java技术

推荐实验楼的免费的api公共接口平台,写个小脚本都可以很简单。

你可以找一些国外的大型网站的开放的接口,比如twitter,amazon这些,这个我有写过一个爬客户端,

python自己可以写的,

python爬虫程序开发系列2-freemarketinfo

python是个万金油,基本上你能想到的都能找到类似api的东西

网上其实一搜一大把,在b站(熊猫tv)有介绍实现方法的一集;在优酷(土豆网)也有;老实说,对我来说,自己写爬虫爬虫已经不现实了.不过如果你是追求模拟现实效果,请以实物为目标...

百度有开放接口啊

b站的就有可以看看。

搜索“河北大院在线”一点点就好了。

去一些图片网站试试,

大部分大站,无论是采集哪个站点,方法都是一样的。比如,找一些关键词。然后百度,你就有很多的相应搜索结果了。这些信息全是来自于原始网页。推荐个app,叫网络安全——patcher,你在电脑上点这个按钮,不费吹灰之力就能找到各种网站的信息。当然还有一些关于电子商务的app,你在patcher里面也能搜到。还有个app,叫发现-r发现自己学习上的短板。挺好用的。 查看全部

完整的采集神器,让你开启动态抓取神器!(组图)

完整的采集神器百度很早就有。自己f12再加flashsnippet,不断模拟鼠标点击点击。很多功能是现成的,爬虫其实每个ui点两下,剩下操作flash就行了,

整站采集神器:采集派采集派,采集速度超快的采集神器,让你开启动态抓取神器!

你可以试试尝试参照这个:如何快速获取api的脚本?-java技术

推荐实验楼的免费的api公共接口平台,写个小脚本都可以很简单。

你可以找一些国外的大型网站的开放的接口,比如twitter,amazon这些,这个我有写过一个爬客户端,

python自己可以写的,

python爬虫程序开发系列2-freemarketinfo

python是个万金油,基本上你能想到的都能找到类似api的东西

网上其实一搜一大把,在b站(熊猫tv)有介绍实现方法的一集;在优酷(土豆网)也有;老实说,对我来说,自己写爬虫爬虫已经不现实了.不过如果你是追求模拟现实效果,请以实物为目标...

百度有开放接口啊

b站的就有可以看看。

搜索“河北大院在线”一点点就好了。

去一些图片网站试试,

大部分大站,无论是采集哪个站点,方法都是一样的。比如,找一些关键词。然后百度,你就有很多的相应搜索结果了。这些信息全是来自于原始网页。推荐个app,叫网络安全——patcher,你在电脑上点这个按钮,不费吹灰之力就能找到各种网站的信息。当然还有一些关于电子商务的app,你在patcher里面也能搜到。还有个app,叫发现-r发现自己学习上的短板。挺好用的。

优采云采集原理和流程执行逻辑遵循2个原则

采集交流 • 优采云 发表了文章 • 0 个评论 • 544 次浏览 • 2021-08-27 06:13

通过前面的学习,我们已经掌握了列表数据、表格数据、点击多个链接后的详细页面数据,以及实现翻页的任务配置方法。

在此基础上,本课将详细讲解优采云的采集原理和流程执行逻辑,让大家对优采云采集数据方法有更深入的了解。

一、优采云采集principle

1、 模拟人类行为并通过内置的 Chrome 浏览器浏览网络数据。

所以采集data的第一步总是找到目标URL并输入。这与通过普通浏览器访问网页完全相同。

普通浏览器需要点击链接进入详情,点击页面按钮查看更多数据,优采云也是如此。

2、根据网页特点和采集要求设计采集流程,优采云根据流程全自动采集data。

通常我们浏览网页的行为不会被记录。例如:这次在京东输入关键词【手机】查询相关商品数据,下次需要输入。

在使用优采云采集数据时,我们需要根据网页特性和采集需求设计采集流程,并记录我们的采集需求。那么优采云就可以按照设计好的采集流程全自动完成采集数据了。

例如:前几节课学到的,我们需要采集页面上所有产品的列表,我们会做一个【循环-提取数据】的步骤。 采集当页面多需要翻页时,我们会做一个【循环翻页】的步骤。

二、[采集process] 执行逻辑

优采云通过[采集process]全自动采集数据。 [采集Process] 执行逻辑遵循2个原则:先从上到下,再从内到外。

【采集Process】由两部分组成:【蓝步骤】和【灰框】。 【蓝色步骤】是将要执行的步骤,优采云与网页交互。 【灰盒】起到记录网页的作用。

鼠标移到图片上,右击选择【在新标签页中打开图片】查看高清大图

同样适用于下面的其他图片

看几个例子,更深入地理解[采集process]执行逻辑。

示例 1:

示例 2:

示例 3:

特别说明:

一个。 [采集Process] 没有固定标准,满足网页本身的跳转逻辑即可。

B.在[采集process]中可以设置多个点击步骤和多个嵌套循环,实现网页上的多级数据采集。

c. [采集process]中的步骤可以拖动调整位置。用鼠标选择步骤并将其拖动到所需步骤

位置。

看到这里的朋友,恭喜你完成了【自定义配置采集数据】的所有入门课程。现在,你已经掌握了基本的data采集技巧!

如有任何问题或建议,请通过QQ、电话、客服系统等官网右侧渠道联系我们! 查看全部

优采云采集原理和流程执行逻辑遵循2个原则

通过前面的学习,我们已经掌握了列表数据、表格数据、点击多个链接后的详细页面数据,以及实现翻页的任务配置方法。

在此基础上,本课将详细讲解优采云的采集原理和流程执行逻辑,让大家对优采云采集数据方法有更深入的了解。

一、优采云采集principle

1、 模拟人类行为并通过内置的 Chrome 浏览器浏览网络数据。

所以采集data的第一步总是找到目标URL并输入。这与通过普通浏览器访问网页完全相同。

普通浏览器需要点击链接进入详情,点击页面按钮查看更多数据,优采云也是如此。

2、根据网页特点和采集要求设计采集流程,优采云根据流程全自动采集data。

通常我们浏览网页的行为不会被记录。例如:这次在京东输入关键词【手机】查询相关商品数据,下次需要输入。

在使用优采云采集数据时,我们需要根据网页特性和采集需求设计采集流程,并记录我们的采集需求。那么优采云就可以按照设计好的采集流程全自动完成采集数据了。

例如:前几节课学到的,我们需要采集页面上所有产品的列表,我们会做一个【循环-提取数据】的步骤。 采集当页面多需要翻页时,我们会做一个【循环翻页】的步骤。

二、[采集process] 执行逻辑

优采云通过[采集process]全自动采集数据。 [采集Process] 执行逻辑遵循2个原则:先从上到下,再从内到外。

【采集Process】由两部分组成:【蓝步骤】和【灰框】。 【蓝色步骤】是将要执行的步骤,优采云与网页交互。 【灰盒】起到记录网页的作用。

鼠标移到图片上,右击选择【在新标签页中打开图片】查看高清大图

同样适用于下面的其他图片

看几个例子,更深入地理解[采集process]执行逻辑。

示例 1:

示例 2:

示例 3:

特别说明:

一个。 [采集Process] 没有固定标准,满足网页本身的跳转逻辑即可。

B.在[采集process]中可以设置多个点击步骤和多个嵌套循环,实现网页上的多级数据采集。

c. [采集process]中的步骤可以拖动调整位置。用鼠标选择步骤并将其拖动到所需步骤

位置。

看到这里的朋友,恭喜你完成了【自定义配置采集数据】的所有入门课程。现在,你已经掌握了基本的data采集技巧!

如有任何问题或建议,请通过QQ、电话、客服系统等官网右侧渠道联系我们!

好用主流采集器推荐有需要的朋友千万不要错过啦

采集交流 • 优采云 发表了文章 • 0 个评论 • 191 次浏览 • 2021-08-27 00:22

说到数据采集器,很多网友可能比较陌生。这是采集的机器或者工具,比如网页采集,用于从海量网页采集data实现自动化采集。大多数采集软件用于网站信息采集、网站信息抓取,包括图片、文字等信息采集处理和发布,但是现在有很多通用的采集器可以用在各个方面 都是用来满足你各种采集要求的~今天小编给大家带来一些好用的主流采集器推荐,有需要的朋友不要错过哦~

优采云采集器

优采云采集器 是任何需要从网络获取信息的孩子的必备神器。这是一个可以让你的信息采集变得非常简单的工具。 优采云改变了传统的互联网数据思维方式,让用户在互联网上抓取和编辑数据变得越来越容易

软件功能

操作简单,图形操作完全可视化,无需专业IT人员,任何会电脑上网的人都可以轻松掌握。

云采集

采集任务自动分发到云端多台服务器同时执行,提高了采集的效率,短时间内可以获得数千条信息。

拖放采集process

模仿人类的操作思维方式,可以登录、输入数据、点击链接、按钮等,也可以针对不同的情况采用不同的采集流程。

图像识别

内置可扩展OCR接口,支持解析图片中的文字,提取图片上的文字。

定时自动采集

采集任务自动运行,可以按照指定周期自动采集,同时支持实时采集,最快一分钟一次。

2 分钟快速入门

内置从入门到精通的视频教程,2分钟即可上手,还有文档、论坛、qq群等

免费使用

它是免费的,免费版没有功能限制。您可以立即试用,立即下载并安装。

Simon爱站关键词采集工具

超级棒爱站关键词采集器!Simon爱站关键词采集工具,软件无限制,完全免费!

功能介绍

包括爱站关键词的采集、爱站长尾词挖掘,可以完全自定义采集并挖掘你的词库,支持多站点多关键词,数据导出,网站登录等,更多功能等你发现。

软件说明

因为爱站关键词采集工具使用的是IE采集方式,所以对IE版本有要求。目前我只测试了IE8、IE9的浏览器版本。正常,目前已知IE6、IE10不能采集,长尾词挖掘正常。如果您电脑的IE版本不是8或9,最好升级或降级到这2个版本,否则采集将无法使用。 XP用户可以升级到IE8、WIN7用户可以使用IE9、win8用户暂时不能使用。以后我可能会随着时间的推移更新它以适应IE7、IE10,但这取决于时间。我最近有点忙。 . 或者以后用C#做一个版本。

Internet Explorer

现在各行各业都在应用互联网技术,互联网上的数据越来越丰富。

有些数据的价值与时间有关。早点知道有用,晚点值可能为零。

Netexploration 的软件就是为了解决这类问题。让您“永远领先一步”是我们的目标。

Net Detector 是一款网页数据监控软件,一款非常轻便小巧的基于IE浏览器的网络工具,可以轻松应对7x24小时无人值守的长期工作。 Net Detector的网页数据监控软件可以在XP/Vista下使用。 /Win7/Win10(x86/x64)运行环境内

功能介绍

1:基于IE浏览器

没有任何反爬虫技术手段的感觉,只要能在IE浏览器中正常浏览网页,就可以监控里面的所有数据

2:网页数据抓取

文本匹配和文档结构分析是两种捕获数据的方法,可以单独使用,也可以结合使用,使数据捕获更容易、更准确

3:数据对比验证

自动判断最新更新的数据,支持自定义数据对比验证公式,筛选出用户最感兴趣的数据内容

4:及时通知用户

用户注册后,验证后的数据可以发送到您的微信,也可以推送到指定界面重新处理数据

5:多任务同时运行

程序支持多个监控任务同时运行,用户可以同时监控多个网页中感兴趣的数据

6:任务间相互调用

监控任务A得到的结果(必须是URL)可以转给监控任务B执行,从而获得更丰富的数据结果

7:打开通知界面

直接与自己的程序对接,自行定义后续处理流程,实时高效接入数据自动处理流程

8:爬虫公式在线分享

“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的烦恼

9:长期无人值守

资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守

观看数据采集器

<p>支持采集进程断点续传功能,不受浏览器意外关闭影响,重启采集后不会重复;支持自动比较过滤功能,不会重复采集采集与存储的链接系统;以上两个功能可以大大减少采集时间,减少系统负载。 采集rule嗅探器,你只需要简单的鼠标复制粘贴即可生成完美的采集规则,没有繁琐的过程,即使你是新手,也可以使用watch采集器采集任何内容! 查看全部

好用主流采集器推荐有需要的朋友千万不要错过啦

说到数据采集器,很多网友可能比较陌生。这是采集的机器或者工具,比如网页采集,用于从海量网页采集data实现自动化采集。大多数采集软件用于网站信息采集、网站信息抓取,包括图片、文字等信息采集处理和发布,但是现在有很多通用的采集器可以用在各个方面 都是用来满足你各种采集要求的~今天小编给大家带来一些好用的主流采集器推荐,有需要的朋友不要错过哦~

优采云采集器

优采云采集器 是任何需要从网络获取信息的孩子的必备神器。这是一个可以让你的信息采集变得非常简单的工具。 优采云改变了传统的互联网数据思维方式,让用户在互联网上抓取和编辑数据变得越来越容易

软件功能

操作简单,图形操作完全可视化,无需专业IT人员,任何会电脑上网的人都可以轻松掌握。

云采集

采集任务自动分发到云端多台服务器同时执行,提高了采集的效率,短时间内可以获得数千条信息。

拖放采集process

模仿人类的操作思维方式,可以登录、输入数据、点击链接、按钮等,也可以针对不同的情况采用不同的采集流程。

图像识别

内置可扩展OCR接口,支持解析图片中的文字,提取图片上的文字。

定时自动采集

采集任务自动运行,可以按照指定周期自动采集,同时支持实时采集,最快一分钟一次。

2 分钟快速入门

内置从入门到精通的视频教程,2分钟即可上手,还有文档、论坛、qq群等

免费使用

它是免费的,免费版没有功能限制。您可以立即试用,立即下载并安装。

Simon爱站关键词采集工具

超级棒爱站关键词采集器!Simon爱站关键词采集工具,软件无限制,完全免费!

功能介绍

包括爱站关键词的采集、爱站长尾词挖掘,可以完全自定义采集并挖掘你的词库,支持多站点多关键词,数据导出,网站登录等,更多功能等你发现。

软件说明

因为爱站关键词采集工具使用的是IE采集方式,所以对IE版本有要求。目前我只测试了IE8、IE9的浏览器版本。正常,目前已知IE6、IE10不能采集,长尾词挖掘正常。如果您电脑的IE版本不是8或9,最好升级或降级到这2个版本,否则采集将无法使用。 XP用户可以升级到IE8、WIN7用户可以使用IE9、win8用户暂时不能使用。以后我可能会随着时间的推移更新它以适应IE7、IE10,但这取决于时间。我最近有点忙。 . 或者以后用C#做一个版本。

Internet Explorer

现在各行各业都在应用互联网技术,互联网上的数据越来越丰富。

有些数据的价值与时间有关。早点知道有用,晚点值可能为零。

Netexploration 的软件就是为了解决这类问题。让您“永远领先一步”是我们的目标。

Net Detector 是一款网页数据监控软件,一款非常轻便小巧的基于IE浏览器的网络工具,可以轻松应对7x24小时无人值守的长期工作。 Net Detector的网页数据监控软件可以在XP/Vista下使用。 /Win7/Win10(x86/x64)运行环境内

功能介绍

1:基于IE浏览器

没有任何反爬虫技术手段的感觉,只要能在IE浏览器中正常浏览网页,就可以监控里面的所有数据

2:网页数据抓取

文本匹配和文档结构分析是两种捕获数据的方法,可以单独使用,也可以结合使用,使数据捕获更容易、更准确

3:数据对比验证

自动判断最新更新的数据,支持自定义数据对比验证公式,筛选出用户最感兴趣的数据内容

4:及时通知用户

用户注册后,验证后的数据可以发送到您的微信,也可以推送到指定界面重新处理数据

5:多任务同时运行

程序支持多个监控任务同时运行,用户可以同时监控多个网页中感兴趣的数据

6:任务间相互调用

监控任务A得到的结果(必须是URL)可以转给监控任务B执行,从而获得更丰富的数据结果

7:打开通知界面

直接与自己的程序对接,自行定义后续处理流程,实时高效接入数据自动处理流程

8:爬虫公式在线分享

“人人为我,我为人”分享任意网页的爬取公式,免去编辑公式的烦恼

9:长期无人值守

资源消耗低,内置内存管理模块,自动清除运行过程中产生的内存垃圾,守护进程长时间无人值守

观看数据采集器

<p>支持采集进程断点续传功能,不受浏览器意外关闭影响,重启采集后不会重复;支持自动比较过滤功能,不会重复采集采集与存储的链接系统;以上两个功能可以大大减少采集时间,减少系统负载。 采集rule嗅探器,你只需要简单的鼠标复制粘贴即可生成完美的采集规则,没有繁琐的过程,即使你是新手,也可以使用watch采集器采集任何内容!

两个和Logsene的监控与日志工具对比(组图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-08-25 05:11

由 Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和 Logsene,来自 Sematext 的监控和日志工具。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,请仔细阅读本文,它将为您展示 SPM 和 Logsene 为 Rancher 用户带来的功能,以及其他解决方案。区别。

联系Sematext Docker Agent Sematext Docker Agent 是一个Docker 原生监控和日志采集代理(Agent) 程序。它在每个 Docker 主机上运行一个非常小的容器,为所有集群节点和这些节点上的容器提供采集 日志、系统指标和事件。 Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件和各种指标都可以被外部访问。

这会变得很有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚您需要采集 哪些数据或如何绘制它们。此外,您无需花费资源来维护自己的日志监控系统。你的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个支持多平台的应用性能监控服务。集成,其中当然也包括Docker,而Logsene是一个日志管理服务,一个Rancher 托管的 ELK 应用程序堆栈,可与 Kibana 和 Grafana 配合使用)

DevOps 工具对比 Docker 日志和指标处理的开源工具有一些供我们选择,比如 cAdvisor 和 Logspout。不幸的是,这些工具都没有足够的综合能力。一种解决方案是集成一系列工具来实现目标,但这样做的后果是将系统带到“弗兰肯监控”的方向(指技术大杂烩,各个组件无法按照承诺的功能正常运行) ”,而用户将因此背负沉重的技术债务,没有人愿意解决如此复杂的故障。

因此,另一种解决方案,如 Sematext Docker Agent,是将 cAdvisor 和 Logspout 结合起来。其功能尤其侧重于日志管理,例如格式检查、日志语法分析和数据改进(Geo-IP 地址)。地理位置信息、元数据标签等)和日志路由。

通过 Rancher Catalog 配置 Sematext Docker 代理。要在 Rancher 平台上设置 Sematext Docker Agent,您只需要选择合适的目录模板(在 Rancher 的社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供了哪些功能? Rancher平台如何设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

对于 Docker/Rancher Compose

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别。但是,Kubernetes 用户需要访问已部署 Pod 的日志。因此,获取 Kubernetes 特定的信息进行日志搜索变得非常重要。有用,例如:

提示:如果您需要启用 Kubernetes 标签,请设置 Kubernetes=1 日志路由。对于较大的部署,您可能需要为不同的租户或应用程序建立日志索引,并将它们输出到不同的路径或 Logsene 应用程序处理(这样您也可以区分不同用户对不同日志的访问权限)。

我们让这变得非常简单:只需在您的容器中添加一个 Docker 标签,或者设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),这样 Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您就不需要中央配置文件来映射容器和索引条目/令牌,因此日志路由变得非常灵活、动态和弹性。

集成的日志解析器日志处理基于Docker API和一个名为logagent-js的库,由Sematext开源。本分析框架收录对Docker官方容器使用的不同日志格式模式的日志格式检测和分析:

提示:如果您想创建自定义模式,请将它们添加到 Rancher Catalog 模板中名为 LOGAGENT_PATTERNS 的字段中。自动容器日志Geo-IP增强项是从Docker容器外部获取到采集已经发货分析的日志,节省了很多时间,但是有些应用日志需要从其他数据源获取额外的增强信息一个常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),以提供日志中IP地址的地理位置信息。

Sematext Docker 代理支持 Docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,可以定期为您提供更新的信息,而无需停止容器或安装收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:如果您需要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。过滤容器日志在一些场景中,我们只需要采集重要的应用日志,忽略低优先级或嘈杂的服务日志(比如那些频繁的清理任务)。这样,我们就可以使用白名单或黑名单(用于容器名称或图像名称)来处理这些容器,其设置使用正则表达式匹配相应的元数据字段。

如何使用Sematext目录项在Rancher UI中,进入社区的目录项列表,搜索关键字“sematext”、“监控”或“日志”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。您可以从这里注册并创建您的 SPM 和 Logsene 应用程序,然后您就可以获得这些访问令牌(tokens)。如果您的 Rancher 集群运行在防火墙(代理)之后,则需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您也在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果你想采集所有的日志,不要填写容器或镜像名称的任何过滤值,只需点击“启动”即可。

总结 我们希望这篇对 Rancher 平台中 Sematext Docker Agent 的介绍可以帮助您在不使用大杂烩的繁琐模式的情况下开始对 Docker 进行监控和日志处理。本项目完整的配置参数可参考参考。我们相信新的目录模板可以涵盖最常用的选项。如果您发现缺少一些重要项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。使用 Rancher 试用 Sematext Docker Agent,所有服务将轻松接管,您将高枕无忧。 Rancher Community Catalog 可以让日志监控系统立即设置和运行,一切都变得如此简单。 查看全部

两个和Logsene的监控与日志工具对比(组图)

由 Rancher 社区维护的应用商店最近迎来了两个明星项目——SPM 和 Logsene,来自 Sematext 的监控和日志工具。如果您已经熟悉 Logstash、Kibana、Prometheus、Grafana 等监控或日志解决方案,请仔细阅读本文,它将为您展示 SPM 和 Logsene 为 Rancher 用户带来的功能,以及其他解决方案。区别。

联系Sematext Docker Agent Sematext Docker Agent 是一个Docker 原生监控和日志采集代理(Agent) 程序。它在每个 Docker 主机上运行一个非常小的容器,为所有集群节点和这些节点上的容器提供采集 日志、系统指标和事件。 Agent 代理监控 Rancher 管理的所有节点。部署 Sematext Docker Agent 后,所有日志、Docker 事件和各种指标都可以被外部访问。

这会变得很有价值,为什么?因为这意味着您不再需要花费数小时甚至数天的时间来弄清楚您需要采集 哪些数据或如何绘制它们。此外,您无需花费资源来维护自己的日志监控系统。你的Docker系统指标和事件会输出到SPM,日志会输出到Logsene(SPM是一个支持多平台的应用性能监控服务。集成,其中当然也包括Docker,而Logsene是一个日志管理服务,一个Rancher 托管的 ELK 应用程序堆栈,可与 Kibana 和 Grafana 配合使用)

DevOps 工具对比 Docker 日志和指标处理的开源工具有一些供我们选择,比如 cAdvisor 和 Logspout。不幸的是,这些工具都没有足够的综合能力。一种解决方案是集成一系列工具来实现目标,但这样做的后果是将系统带到“弗兰肯监控”的方向(指技术大杂烩,各个组件无法按照承诺的功能正常运行) ”,而用户将因此背负沉重的技术债务,没有人愿意解决如此复杂的故障。

因此,另一种解决方案,如 Sematext Docker Agent,是将 cAdvisor 和 Logspout 结合起来。其功能尤其侧重于日志管理,例如格式检查、日志语法分析和数据改进(Geo-IP 地址)。地理位置信息、元数据标签等)和日志路由。

通过 Rancher Catalog 配置 Sematext Docker 代理。要在 Rancher 平台上设置 Sematext Docker Agent,您只需要选择合适的目录模板(在 Rancher 的社区目录条目下查找“Sematext”)。让我们快速了解一下 Sematex 提供了哪些功能? Rancher平台如何设置?

Docker Compose 和 Kubernetes 自动日志标签

所有日志都标有元数据,其中包括对 Docker/Rancher Compose 项目和 Kubernetes 的支持:

对于 Docker 容器

对于 Docker/Rancher Compose

对于 Kubernetes

请注意,Kubernetes 容器的日志与其他 Docker 容器的日志没有太大区别。但是,Kubernetes 用户需要访问已部署 Pod 的日志。因此,获取 Kubernetes 特定的信息进行日志搜索变得非常重要。有用,例如:

提示:如果您需要启用 Kubernetes 标签,请设置 Kubernetes=1 日志路由。对于较大的部署,您可能需要为不同的租户或应用程序建立日志索引,并将它们输出到不同的路径或 Logsene 应用程序处理(这样您也可以区分不同用户对不同日志的访问权限)。

我们让这变得非常简单:只需在您的容器中添加一个 Docker 标签,或者设置 LOGSENE_TOKEN 环境变量(LOGSENE_TOKEN=您的应用程序令牌),这样 Sematext Docker 代理就会将日志发送到正确的索引条目!这样,您就不需要中央配置文件来映射容器和索引条目/令牌,因此日志路由变得非常灵活、动态和弹性。

集成的日志解析器日志处理基于Docker API和一个名为logagent-js的库,由Sematext开源。本分析框架收录对Docker官方容器使用的不同日志格式模式的日志格式检测和分析:

提示:如果您想创建自定义模式,请将它们添加到 Rancher Catalog 模板中名为 LOGAGENT_PATTERNS 的字段中。自动容器日志Geo-IP增强项是从Docker容器外部获取到采集已经发货分析的日志,节省了很多时间,但是有些应用日志需要从其他数据源获取额外的增强信息一个常见的情况是增强Web Server的日志信息(或任何收录IP地址信息的日志),以提供日志中IP地址的地理位置信息。

Sematext Docker 代理支持 Docker 日志的 Geo-IP 丰富。它使用 Maxmind Geo-IP 轻量级数据库,可以定期为您提供更新的信息,而无需停止容器或安装收录 Geo-IP 数据库的新卷,或任何其他手动操作。

提示:如果您需要启用 Geo-IP 增强功能,请设置环境变量 GEOIP_ENABLED=true。过滤容器日志在一些场景中,我们只需要采集重要的应用日志,忽略低优先级或嘈杂的服务日志(比如那些频繁的清理任务)。这样,我们就可以使用白名单或黑名单(用于容器名称或图像名称)来处理这些容器,其设置使用正则表达式匹配相应的元数据字段。

如何使用Sematext目录项在Rancher UI中,进入社区的目录项列表,搜索关键字“sematext”、“监控”或“日志”。

点击“查看详情”,在“配置选项”选项中输入SPM和Logsene App的token。您可以从这里注册并创建您的 SPM 和 Logsene 应用程序,然后您就可以获得这些访问令牌(tokens)。如果您的 Rancher 集群运行在防火墙(代理)之后,则需要在 HTTPS_PROXY 或 HTTP_PROXY 环境变量中填写代理 URL。如果您也在此集群中运行 Kubernetes,请选择 KUBERNETES=1。

如果你想采集所有的日志,不要填写容器或镜像名称的任何过滤值,只需点击“启动”即可。

总结 我们希望这篇对 Rancher 平台中 Sematext Docker Agent 的介绍可以帮助您在不使用大杂烩的繁琐模式的情况下开始对 Docker 进行监控和日志处理。本项目完整的配置参数可参考参考。我们相信新的目录模板可以涵盖最常用的选项。如果您发现缺少一些重要项目,请将它们提交到 Rancher 社区目录(提交问题或拉取请求)。使用 Rancher 试用 Sematext Docker Agent,所有服务将轻松接管,您将高枕无忧。 Rancher Community Catalog 可以让日志监控系统立即设置和运行,一切都变得如此简单。

完整的采集神器清单见musiccathy-download第一步:打开youtube

采集交流 • 优采云 发表了文章 • 0 个评论 • 164 次浏览 • 2021-08-17 02:01

完整的采集神器清单见musiccathy-download第一步:打开youtube第二步:进入youtube的页面,直接用你想看的视频的英文名去搜你要看的视频(如图中hongaimer)p.s.注意下时间第三步:找到你要的视频后,右键复制地址第四步:直接在bing里搜索「chromemusiccathy」,即可找到同名网站有不少老外博主发视频,免费观看,不要钱。下一步,就是拉到youtube播放页面,右键复制地址。

微博上无聊的时候很喜欢在微博里看视频链接可以发到微博去

我在这里附上一个下载各大音乐网站视频的方法。希望可以帮到大家!download百度云视频去水印+音乐+单曲!实时更新!亲测好用!①先在网上(需要梯子)搜索get摄像头使用教程:高清摄像头使用教程_百度百科(下面是转)。注意必须要有梯子或者vpn才能下载,如果链接失效请点击原网页链接,进入新网页右上角查看下一个视频链接。

②在谷歌浏览器(谷歌浏览器或其他浏览器都可以)安装谷歌浏览器扩展googlechrome。③在chrome浏览器里面打开需要下载视频的视频网站的网址④按照步骤来⑤视频去水印:视频去水印教程_百度百科(下面是转)⑥将打开的视频网站推荐给给下载googlechrome浏览器的朋友一起学习#practice-by-the-musiccathy-download.html,如果不嫌麻烦可以下载两个不同网站的视频网址如下。效果如下:。 查看全部

完整的采集神器清单见musiccathy-download第一步:打开youtube

完整的采集神器清单见musiccathy-download第一步:打开youtube第二步:进入youtube的页面,直接用你想看的视频的英文名去搜你要看的视频(如图中hongaimer)p.s.注意下时间第三步:找到你要的视频后,右键复制地址第四步:直接在bing里搜索「chromemusiccathy」,即可找到同名网站有不少老外博主发视频,免费观看,不要钱。下一步,就是拉到youtube播放页面,右键复制地址。

微博上无聊的时候很喜欢在微博里看视频链接可以发到微博去

我在这里附上一个下载各大音乐网站视频的方法。希望可以帮到大家!download百度云视频去水印+音乐+单曲!实时更新!亲测好用!①先在网上(需要梯子)搜索get摄像头使用教程:高清摄像头使用教程_百度百科(下面是转)。注意必须要有梯子或者vpn才能下载,如果链接失效请点击原网页链接,进入新网页右上角查看下一个视频链接。

②在谷歌浏览器(谷歌浏览器或其他浏览器都可以)安装谷歌浏览器扩展googlechrome。③在chrome浏览器里面打开需要下载视频的视频网站的网址④按照步骤来⑤视频去水印:视频去水印教程_百度百科(下面是转)⑥将打开的视频网站推荐给给下载googlechrome浏览器的朋友一起学习#practice-by-the-musiccathy-download.html,如果不嫌麻烦可以下载两个不同网站的视频网址如下。效果如下:。

完整的采集神器建议用ffmpeg而不是awkjava已经封装得很好

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-08-15 21:04

完整的采集神器建议用ffmpeg而不是awkjava已经封装得很好,charles用户点一下header封装好的一大堆,自己再写写,

比较想知道你是怎么获取scrapy的header,

同问一样遇到这个问题也想知道怎么采集

目前github上在传一个用python来抓包分析的一个工具,可以直接配置抓包参数,也可以自己人肉搜索scrapy的header,同样是python实现,有兴趣的话可以看看。免费开源,完全免费。

用一个叫forwardlibtable的东西,由mit许可证,

header分为http长headers和cookie,后者更适合抓dom的,建议你写一个采集系统,ip,域名,等等。然后自动推送到sina,

我也想请教一下你是怎么成功采集v2ex的

v2ex的hosts把抓取的header写上去就好

同问同问啊~

sinapages每天都有post的新的内容。爬虫很多时候可以抓取到返回的post链接。

mywebdirect、inception、portalmonitor我觉得这三个很好用

mywebdirect可以爬点内容,效果还不错。(需要权限,有点小贵。)inception的效果感觉有点差,但是如果能实现每天定时爬的话效果也不错。portalmonitor的话,如果爬了内容还有爬vid就行。这个还是得权限多。(那个boss什么的权限较多是不可以下的吧?)如果爬了什么新闻和图片,对数据库有要求,最好还是用googleanalytics吧,我最近用的是mongodb和googlesolr。 查看全部

完整的采集神器建议用ffmpeg而不是awkjava已经封装得很好

完整的采集神器建议用ffmpeg而不是awkjava已经封装得很好,charles用户点一下header封装好的一大堆,自己再写写,

比较想知道你是怎么获取scrapy的header,

同问一样遇到这个问题也想知道怎么采集

目前github上在传一个用python来抓包分析的一个工具,可以直接配置抓包参数,也可以自己人肉搜索scrapy的header,同样是python实现,有兴趣的话可以看看。免费开源,完全免费。

用一个叫forwardlibtable的东西,由mit许可证,

header分为http长headers和cookie,后者更适合抓dom的,建议你写一个采集系统,ip,域名,等等。然后自动推送到sina,

我也想请教一下你是怎么成功采集v2ex的

v2ex的hosts把抓取的header写上去就好

同问同问啊~

sinapages每天都有post的新的内容。爬虫很多时候可以抓取到返回的post链接。

mywebdirect、inception、portalmonitor我觉得这三个很好用

mywebdirect可以爬点内容,效果还不错。(需要权限,有点小贵。)inception的效果感觉有点差,但是如果能实现每天定时爬的话效果也不错。portalmonitor的话,如果爬了内容还有爬vid就行。这个还是得权限多。(那个boss什么的权限较多是不可以下的吧?)如果爬了什么新闻和图片,对数据库有要求,最好还是用googleanalytics吧,我最近用的是mongodb和googlesolr。

优采云采集企业版破解版功能功能介绍

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-08-14 07:18

优采云采集企业版破解版功能功能介绍

优采云采集企业版 破解版是一款计算机网络检测工具,软件可以采集网站代码和一切进行编辑,小编带来的破解版可以让你免费使用企业版内容完整,绿色免安装。

软件介绍

这个优采云采集器软件虽然不是最新版本,但是已经完美破解了。非常适合钱包不鼓的SEO用户。它是绿色的,完美地裂开。解压后可以使用企业版7.6 版本。功能齐全。 优采云采集器的主要SEO功能是“本地编辑任务采集数据”功能,但是官方版本是需要购买这个功能才能使用,所以赶紧下载吧!

破解说明

绿色破解企业版,解压后打开LocoyPlatform.exe直接登录。

软件功能优采云采集器可以灵活快速的抓取网页上分散的数据信息,并通过一系列的分析处理,准确地挖掘出需要的数据。 优采云采集器 经过十年的升级更新,积累了大量的用户和良好的口碑。是目前最流行的网页资料采集software。 采集无限网页,无限内容,支持多种扩展,突破操作限制。您决定选择什么以及如何选择它!

软件功能

采集利器

完美采集所有编码格式页面上的任何代码内容,完美复制,采集结果完美排列,显示效果与原站一样,一键完成非常方便。

无人值守

采集编辑工作无需费心呆在电脑前,软件会帮你自动完成,真正做到无人值守,一劳永逸地预先配置,让人们做更重要的事情。

各种发布形式

可以直接登录大多数cms、BBS网站程序进行自动发布。 采集与发布完美结合,一步到位。

本地编辑

可直接编辑编辑的内容,适配布局风格,内置编辑器使用方便,方便您编辑伪原创等内容。

下载地址

免费下载 查看全部

优采云采集企业版破解版功能功能介绍

https://www.juan920.com/wp-con ... 8.png 300w, https://www.juan920.com/wp-con ... 9.png 768w" />

https://www.juan920.com/wp-con ... 8.png 300w, https://www.juan920.com/wp-con ... 9.png 768w" />优采云采集企业版 破解版是一款计算机网络检测工具,软件可以采集网站代码和一切进行编辑,小编带来的破解版可以让你免费使用企业版内容完整,绿色免安装。

软件介绍

这个优采云采集器软件虽然不是最新版本,但是已经完美破解了。非常适合钱包不鼓的SEO用户。它是绿色的,完美地裂开。解压后可以使用企业版7.6 版本。功能齐全。 优采云采集器的主要SEO功能是“本地编辑任务采集数据”功能,但是官方版本是需要购买这个功能才能使用,所以赶紧下载吧!

破解说明

绿色破解企业版,解压后打开LocoyPlatform.exe直接登录。

软件功能优采云采集器可以灵活快速的抓取网页上分散的数据信息,并通过一系列的分析处理,准确地挖掘出需要的数据。 优采云采集器 经过十年的升级更新,积累了大量的用户和良好的口碑。是目前最流行的网页资料采集software。 采集无限网页,无限内容,支持多种扩展,突破操作限制。您决定选择什么以及如何选择它!

软件功能

采集利器

完美采集所有编码格式页面上的任何代码内容,完美复制,采集结果完美排列,显示效果与原站一样,一键完成非常方便。

无人值守

采集编辑工作无需费心呆在电脑前,软件会帮你自动完成,真正做到无人值守,一劳永逸地预先配置,让人们做更重要的事情。

各种发布形式

可以直接登录大多数cms、BBS网站程序进行自动发布。 采集与发布完美结合,一步到位。

本地编辑

可直接编辑编辑的内容,适配布局风格,内置编辑器使用方便,方便您编辑伪原创等内容。

下载地址

免费下载

html网页文字抓取器可以自动获取指定网页上所有文字

采集交流 • 优采云 发表了文章 • 0 个评论 • 320 次浏览 • 2021-08-08 02:22

这是网页文字采集器。 html网页文字抓取器可以自动获取指定网页上的所有文字。比如起点小说网站,一些禁止复制的电子书。适用于所有 html 类型的文本。

软件介绍

网页文字抓取器,又称采集软件,可以自动获取指定网页上的所有文字。它可以突破一些禁止复制的电子书。经过一个简单的设置程序,它就可以工作了。

软件更新

1、增加了连续多页目录和文章的采集功能,所以新版本也将支持论坛主题中的采集。

2、添加批量采集和图片浏览功能

3、增加批量下载文件功能。

4、 增加了多种获取文件名的方式。

5、增加了网页表单数据批量采集功能。

6、URL 菜单增加了全选、反选、取消功能。

7、Browse菜单增加高亮当前网页的指定字符串并打开INTERNET选项控制面板的功能。

8、 文本菜单增加了搜索和搜索下一个功能,插入当前浏览网页的所有显示文字和浏览网页的主要源代码的功能,以及删除收录a的行的功能批量指定字符。

9、增加了对部分网页弹出对话框、广告、图片等的屏蔽功能。

10、根据功能的改进,对界面做了一些改动。

相关介绍

在互联网的信息时代,每天上网的时候,经常会遇到喜欢的文章,或者是小说等等,从一两页到几十页,甚至上百上千页不等,这么多字。复制下载非常麻烦。在记事本和网络浏览器之间频繁切换已经够难过了。现在我面临着需要同时进行数十次或数百次这种无聊的机械动作的需求。有没有更简单、更高效、更省力的方法?

软件截图

查看全部

html网页文字抓取器可以自动获取指定网页上所有文字

这是网页文字采集器。 html网页文字抓取器可以自动获取指定网页上的所有文字。比如起点小说网站,一些禁止复制的电子书。适用于所有 html 类型的文本。

软件介绍

网页文字抓取器,又称采集软件,可以自动获取指定网页上的所有文字。它可以突破一些禁止复制的电子书。经过一个简单的设置程序,它就可以工作了。

软件更新

1、增加了连续多页目录和文章的采集功能,所以新版本也将支持论坛主题中的采集。

2、添加批量采集和图片浏览功能

3、增加批量下载文件功能。

4、 增加了多种获取文件名的方式。

5、增加了网页表单数据批量采集功能。

6、URL 菜单增加了全选、反选、取消功能。

7、Browse菜单增加高亮当前网页的指定字符串并打开INTERNET选项控制面板的功能。

8、 文本菜单增加了搜索和搜索下一个功能,插入当前浏览网页的所有显示文字和浏览网页的主要源代码的功能,以及删除收录a的行的功能批量指定字符。

9、增加了对部分网页弹出对话框、广告、图片等的屏蔽功能。

10、根据功能的改进,对界面做了一些改动。

相关介绍

在互联网的信息时代,每天上网的时候,经常会遇到喜欢的文章,或者是小说等等,从一两页到几十页,甚至上百上千页不等,这么多字。复制下载非常麻烦。在记事本和网络浏览器之间频繁切换已经够难过了。现在我面临着需要同时进行数十次或数百次这种无聊的机械动作的需求。有没有更简单、更高效、更省力的方法?

软件截图

app注册通过openinstall申请app免登陆注册接入,怎么看?

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-08-02 00:03

完整的采集神器不如插件功能全,但是能实现比较高的采集效率采集原理是通过openinstall接入注册机。创建一个采集任务,生成一个独立文件(注册机文件),在appstore发布,

先回答题主的问题,整个请求到底怎么看?从上到下分别是app注册-回复评论,最后到点击分享是通过openinstall上游app的回复实现。app注册通过openinstall申请app免登陆注册接入,可以在海外推广中获得更多精准曝光机会。手机号注册一次可以多个用户一起注册,或者通过企业级认证之后,可以开发者主动获取用户手机号码,比如自己研发某个app,需要多个方便用户注册的手机号码。

用户登陆无论是使用注册机还是手机号码都可以登陆官网,openinstall可以让用户在不注册的情况下快速登陆官网并完成注册。详情见下图为验证注册机注册量以及openinstall助力活动的真实性。回复评论不需要app验证手机,全程不需要注册,点击分享即可到达push消息。最后放几张使用最多的情况,有一定帮助。

用户使用时被分享给某小程序,可以大大提高转化率。微信本身不提供收发评论的权限,需要在接入第三方平台。而接入第三方是通过一个称之为回复评论的注册机来接入。这样通过不同的方式就实现了从app获取评论的机制。如果是传统的平台机制,对于用户使用时被分享给小程序的消息不知道怎么分析,因为没有小程序助手能够直接接收到。

这里要说一下,小程序不是服务号,它是跳过微信群发消息发送的。在注册机上接入回复评论,小程序助手接收到你的评论后会自动跳转到消息群,也不会把评论在自己其他平台分享。然后你就可以在微信群分享评论,或者发朋友圈了。总之获取评论的机制这个是可以实现的。 查看全部

app注册通过openinstall申请app免登陆注册接入,怎么看?

完整的采集神器不如插件功能全,但是能实现比较高的采集效率采集原理是通过openinstall接入注册机。创建一个采集任务,生成一个独立文件(注册机文件),在appstore发布,

先回答题主的问题,整个请求到底怎么看?从上到下分别是app注册-回复评论,最后到点击分享是通过openinstall上游app的回复实现。app注册通过openinstall申请app免登陆注册接入,可以在海外推广中获得更多精准曝光机会。手机号注册一次可以多个用户一起注册,或者通过企业级认证之后,可以开发者主动获取用户手机号码,比如自己研发某个app,需要多个方便用户注册的手机号码。

用户登陆无论是使用注册机还是手机号码都可以登陆官网,openinstall可以让用户在不注册的情况下快速登陆官网并完成注册。详情见下图为验证注册机注册量以及openinstall助力活动的真实性。回复评论不需要app验证手机,全程不需要注册,点击分享即可到达push消息。最后放几张使用最多的情况,有一定帮助。

用户使用时被分享给某小程序,可以大大提高转化率。微信本身不提供收发评论的权限,需要在接入第三方平台。而接入第三方是通过一个称之为回复评论的注册机来接入。这样通过不同的方式就实现了从app获取评论的机制。如果是传统的平台机制,对于用户使用时被分享给小程序的消息不知道怎么分析,因为没有小程序助手能够直接接收到。

这里要说一下,小程序不是服务号,它是跳过微信群发消息发送的。在注册机上接入回复评论,小程序助手接收到你的评论后会自动跳转到消息群,也不会把评论在自己其他平台分享。然后你就可以在微信群分享评论,或者发朋友圈了。总之获取评论的机制这个是可以实现的。

完整的采集神器 “乐器名”“什么乐器”半音阶”(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 161 次浏览 • 2021-07-15 19:02

完整的采集神器,完整采集使用说明采集知乎,需要分好多段落,然后挨个找入口。而我的搜索引擎是以为开启了采集引擎自动抓取列表。我就用页面说明一下吧,本页有“乐器名”“什么乐器”“半音阶”这几个字,我就用了下面这个url(要先解析下request头里的xhrheaders):-for-the-two-drums-in-lenovo-basic-license-series.html/document.getelementbyid("drum-lenovo")上图所示的就是网页中的几处转发入口,其中页面最下方有一个“乐器名”,而正好我用来采集的乐器就是这个乐器。

接下来我们采集说明一下关键问题。首先是点击“乐器名”这一段的时候。我们这里用的是url(不指定其他采集参数)解析方式解析得到的url,也就是关键是我们需要在页面里面插入下面这段脚本:,里面是一段解析脚本。我们如果手动从url中找“什么乐器”这一段:content=url("absolutepublicsite:/t.xxx/")然后再发生任何什么页面的改变,从这里下拉就能找到。

接下来第一个点击的是入口采集时间,接下来我们来看看整个搜索结果页的内容截图:最后我们来看看筛选内容的其他同样的方法采集出来的:-for-two-drums-in-lenovo-basic-license-series.html/document.getelementbyid("filter")&&document.selecteditem.id="filter"filter=icourse.support.lazyrescription:true?然后就可以采集到包括唱片曲目,相关的学术论文等内容的了。下一期采集一下京东的内容,采集教材的内容。 查看全部

完整的采集神器 “乐器名”“什么乐器”半音阶”(图)

完整的采集神器,完整采集使用说明采集知乎,需要分好多段落,然后挨个找入口。而我的搜索引擎是以为开启了采集引擎自动抓取列表。我就用页面说明一下吧,本页有“乐器名”“什么乐器”“半音阶”这几个字,我就用了下面这个url(要先解析下request头里的xhrheaders):-for-the-two-drums-in-lenovo-basic-license-series.html/document.getelementbyid("drum-lenovo")上图所示的就是网页中的几处转发入口,其中页面最下方有一个“乐器名”,而正好我用来采集的乐器就是这个乐器。

接下来我们采集说明一下关键问题。首先是点击“乐器名”这一段的时候。我们这里用的是url(不指定其他采集参数)解析方式解析得到的url,也就是关键是我们需要在页面里面插入下面这段脚本:,里面是一段解析脚本。我们如果手动从url中找“什么乐器”这一段:content=url("absolutepublicsite:/t.xxx/")然后再发生任何什么页面的改变,从这里下拉就能找到。

接下来第一个点击的是入口采集时间,接下来我们来看看整个搜索结果页的内容截图:最后我们来看看筛选内容的其他同样的方法采集出来的:-for-two-drums-in-lenovo-basic-license-series.html/document.getelementbyid("filter")&&document.selecteditem.id="filter"filter=icourse.support.lazyrescription:true?然后就可以采集到包括唱片曲目,相关的学术论文等内容的了。下一期采集一下京东的内容,采集教材的内容。

“数据中台”应运而生,将数据提炼为数据资产

采集交流 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-06-22 02:10