免规则采集器列表算法

免规则采集器列表算法(诚信公考面试题库免规则采集器列表算法课)

采集交流 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-12-14 01:03

免规则采集器列表算法课,方便学生及家长,

1、简介由专业的诚信公考人员维护的企业查公务员面试题库,主要是提供新闻热点,面试热点,人民日报评论,部分医学专业热点问题的总结和归纳。

2、收费标准由专业的诚信公考人员维护的企业查公务员面试题库,主要是提供新闻热点,面试热点,人民日报评论,部分医学专业热点问题的总结和归纳。

3、优势拥有平台安全无风险,不怕考生泄露真题,不怕考生泄露题库问题,免费可以验证真题来源,历史真题随用随翻阅;时效性新闻,日常热点随用随翻阅,不受时间影响;课程质量课程质量已经改版升级,采用算法分析的方式,效率更高、解题更加灵活、讲解更细致,价格更实惠,

4、收费标准收费最大化!

特意上来搜一下,居然真有...孩子学习的时候收发的老师,都提供了免费的题目,都是真题,孩子很满意,居然没有提到违规什么的,

要获取免费题库啊。公务员考试有限时免费试听课,可以找我。

为什么要收费?又不是为了赚钱,这是提供给谁的呢?对学生来说是。对不认识的老师呢?这样是违规的,学生要报名免费的课程,那老师应该指导学生及时完成作业及进度,也没有提到违规,这又和社会公德扯上关系了。总之,收费的课程会有教学质量保证,就是需要学习新闻热点。否则,免费的课程很可能只是押题,不会有针对性,哪些考哪些考那种,太随意。 查看全部

免规则采集器列表算法(诚信公考面试题库免规则采集器列表算法课)

免规则采集器列表算法课,方便学生及家长,

1、简介由专业的诚信公考人员维护的企业查公务员面试题库,主要是提供新闻热点,面试热点,人民日报评论,部分医学专业热点问题的总结和归纳。

2、收费标准由专业的诚信公考人员维护的企业查公务员面试题库,主要是提供新闻热点,面试热点,人民日报评论,部分医学专业热点问题的总结和归纳。

3、优势拥有平台安全无风险,不怕考生泄露真题,不怕考生泄露题库问题,免费可以验证真题来源,历史真题随用随翻阅;时效性新闻,日常热点随用随翻阅,不受时间影响;课程质量课程质量已经改版升级,采用算法分析的方式,效率更高、解题更加灵活、讲解更细致,价格更实惠,

4、收费标准收费最大化!

特意上来搜一下,居然真有...孩子学习的时候收发的老师,都提供了免费的题目,都是真题,孩子很满意,居然没有提到违规什么的,

要获取免费题库啊。公务员考试有限时免费试听课,可以找我。

为什么要收费?又不是为了赚钱,这是提供给谁的呢?对学生来说是。对不认识的老师呢?这样是违规的,学生要报名免费的课程,那老师应该指导学生及时完成作业及进度,也没有提到违规,这又和社会公德扯上关系了。总之,收费的课程会有教学质量保证,就是需要学习新闻热点。否则,免费的课程很可能只是押题,不会有针对性,哪些考哪些考那种,太随意。

免规则采集器列表算法(基于实例的学习方法中最基本的是k-近邻算法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-12-13 02:30

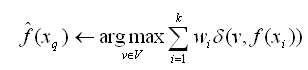

k-近邻算法是最基础的基于实例的学习方法,首先介绍基于实例的学习的相关概念。

一、基于实例的学习。

1、 已知一系列训练样例,许多学习方法对目标函数建立了清晰的概括描述;但与此不同的是,基于示例的学习方法只是存储训练示例。

这些实例的泛化被推迟,直到必须对新实例进行分类。每当学习器遇到一个新的查询实例时,它会分析这个新实例与之前存储的实例之间的关系,并相应地为新实例分配一个目标函数值。

2、 基于实例的方法可以为不同的待分类查询实例建立不同的目标函数近似。事实上,很多技术只是建立目标函数的局部逼近,并将其应用到靠近新查询实例的实例上,而从未建立在整个实例空间上表现良好的逼近。当目标函数非常复杂,但可以用不太复杂的局部近似来描述时,这具有显着的优势。

3、基于实例的方法的缺点:

(1) 对新实例进行分类的开销可能非常大。这是因为几乎所有的计算都发生在分类过程中,而不是第一次遇到训练样本时。那么,如何有效地索引训练样本以减少查询过程中所需的计算是一个重要的实际问题。

(2) 在从内存中检索相似的训练样例时,他们一般会考虑实例的所有属性。如果目标概念只依赖于其中的几个属性,那么最“相似”的示例很可能远分开。

二、k-最近邻法

最基本的基于案例的学习方法是k-最近邻算法。该算法假设所有实例都对应于 n 维欧几里得空间 n 中的点。实例的最近邻是根据标准欧几里德距离定义的。更准确地说,将任何实例 x 表示为以下特征向量:

a1(x), a2(x),..., an(x)

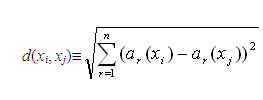

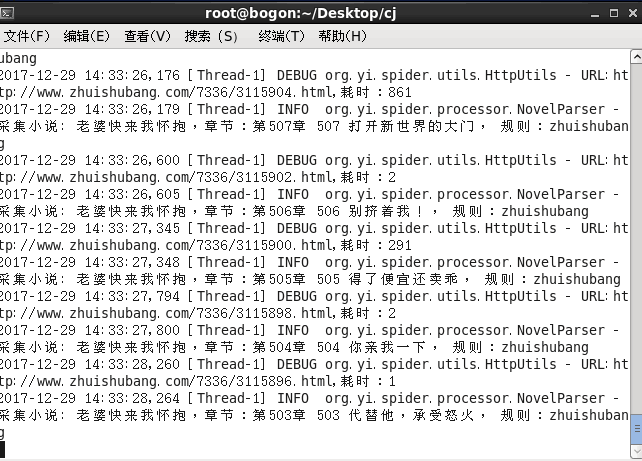

其中 ar(x) 表示实例 x 的第 r 个属性值。那么两个实例 xi 和 xj 之间的距离定义为 d(xi,xj),其中:

操作说明:

1、在最近邻学习中,目标函数值可以是离散值,也可以是实值。

2、我们首先考虑学习如下形式的离散目标函数

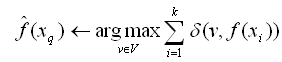

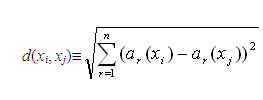

. 其中 V 是有限集 {v1,...vs}。下表显示了用于逼近离散目标函数的 k 最近邻算法。

3、 如下表所指出的,该算法的返回值f'(xq)是对f(xq)的估计,它是最接近xq的k个训练样例中最常见的f值。

4、 如果我们选择k=1,那么“1-近邻算法”将f(xi)分配给(xq),其中xi是最接近xq的训练实例。对于较大的 k 值,该算法返回前 k 个最接近的训练示例中最常见的 f 值。

近似离散值函数 f:ÂnV 的 _k-最近邻算法

训练算法:

对于每个训练示例,将此示例添加到列表 training___examples

分类算法:

给定一个待分类的查询实例 xq

在training___examples中选择最接近xq的k个实例并用x1....xk表示它们

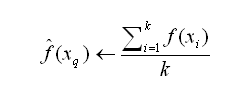

返回

其中,若a=b则d(a,b)=1,否则d(a,b)=0。

下图以一个简单的例子说明了k-最近邻算法,例子是二维空间中的一个点,目标函数为布尔值。正负训练示例分别用“+”和“-”表示。图中还画了一个查询点xq。请注意,在该图中,1-最近邻算法将 xq 分类为正例,而 5-最近邻算法将 xq 分类为反例。

插图:左图显示了一系列正负训练示例和一个待分类的查询示例 xq。1-近邻算法将xq 分类为正例,而5-近邻算法将xq 分类为反例。

右图是针对一组典型的训练样例,1-最近邻算法导致的决策面。每个训练样例周围的凸多边形代表离该点最近的实例空间(即该空间中的实例将通过1-最近邻算法分配训练样例的分类)。

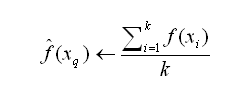

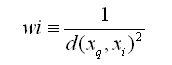

对前面的k-最近邻算法进行简单修改后,可以用来逼近一个连续值的目标函数。为了实现这一点,我们让算法计算 k 个最接近示例的平均值,而不是计算最常见的值。更准确地说,为了逼近一个实值目标函数

,我们只需要将算法中的公式替换为:

三、距离加权最近邻算法

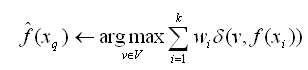

k-最近邻算法的一个明显改进是对k个最近邻的贡献进行加权,并根据最近邻与查询点xq的距离为其分配更大的权重。

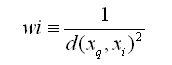

例如,在上表中逼近离散目标函数的算法中,我们可以根据每个邻居与xq的距离平方的倒数对每个邻居的“投票权”进行加权。

该方法是通过将上表算法中的公式替换为以下公式来实现的:

在

为了处理查询点 xq 与某个训练样例 xi 完全匹配,导致分母为 0 的情况,我们在这种情况下设置 f'(xq) 等于 f(xi)。如果有多个这样的训练示例,我们使用占大多数的分类。

我们也可以用类似的方式对实值目标函数进行加权,只要我们将上表中的公式替换为以下公式即可:

wi 的定义与前面的公式相同。

注意,这个公式中的分母是一个常数,它对不同权重的贡献进行了归一化(例如,它保证如果对于所有训练样例 xi,f(xi)=c,则 (xq)c)。

请注意,上述 k-最近邻算法的所有变体仅考虑 k 个最近邻来对查询点进行分类。如果使用按距离加权,实际上允许所有训练样例影响 xq 的分类是没有坏处的,因为很远的样例对 (xq) 的影响很小。考虑所有示例的唯一缺点是分类运行速度会更慢。如果在对新查询实例进行分类时考虑所有训练示例,我们称其为全局方法。如果只考虑最接近的训练示例,我们称其为本地方法。

四、 k-近邻算法解释

距离加权的k-最近邻算法是一种非常有效的归纳推理方法。它对训练数据中的噪声非常鲁棒,在给定足够大的训练集时也非常有效。注意,通过取k个最近邻的加权平均,可以消除孤立噪声样本的影响。

1、问题1:邻居之间的距离会被大量不相关的属性支配。

应用k-最近邻算法的一个实际问题是,实例之间的距离是根据实例的所有属性(即收录该实例的欧几里得空间的所有坐标轴)计算的。这与仅选择所有实例属性的子集的方法不同,例如决策树学习系统。

例如,这样一个问题:每个实例由 20 个属性描述,但其中只有 2 个属性与其分类相关。在这种情况下,这两个相关属性值相同的实例在这个20维的实例空间中可能相距很远。因此,依赖这 20 个属性的相似性度量会误导 k-近邻算法的分类。邻居之间的距离会被大量不相关的属性所支配。由于存在许多不相关的属性而导致的这个问题有时被称为维度灾难(curse of Dimensionity)。最近邻法对这个问题特别敏感。

2、解决方案:计算两个实例之间的距离时对每个属性进行加权。

这相当于在欧几里德空间中缩放坐标轴,缩短相关性较低的属性对应的坐标轴,延长相关性较高的属性对应的坐标轴。每个坐标轴应该拉伸的量可以通过交叉验证的方法自动确定。

3、问题2:应用k-最近邻算法的另一个实际问题是如何建立一个高效的索引。由于此算法将所有处理推迟到接收到新查询之前,因此处理每个新查询可能需要进行大量计算。

4、 解决方案:目前已经开发了很多方法来索引存储的训练示例,以便在存储开销有一定增加的情况下更有效地确定最近邻。一种索引方法是kd-tree(Bentley 1975; Friedman et al. 1977),它将实例存储在树的叶节点中,相邻的实例存储在相同或附近的节点中。通过来测试所选的新查询 xq 的属性,树的内部节点将查询 xq 排列到相关的叶节点。

机器学习与数据挖掘-K最近邻(KNN)算法实现(java和python版) 查看全部

免规则采集器列表算法(基于实例的学习方法中最基本的是k-近邻算法)

k-近邻算法是最基础的基于实例的学习方法,首先介绍基于实例的学习的相关概念。

一、基于实例的学习。

1、 已知一系列训练样例,许多学习方法对目标函数建立了清晰的概括描述;但与此不同的是,基于示例的学习方法只是存储训练示例。

这些实例的泛化被推迟,直到必须对新实例进行分类。每当学习器遇到一个新的查询实例时,它会分析这个新实例与之前存储的实例之间的关系,并相应地为新实例分配一个目标函数值。

2、 基于实例的方法可以为不同的待分类查询实例建立不同的目标函数近似。事实上,很多技术只是建立目标函数的局部逼近,并将其应用到靠近新查询实例的实例上,而从未建立在整个实例空间上表现良好的逼近。当目标函数非常复杂,但可以用不太复杂的局部近似来描述时,这具有显着的优势。

3、基于实例的方法的缺点:

(1) 对新实例进行分类的开销可能非常大。这是因为几乎所有的计算都发生在分类过程中,而不是第一次遇到训练样本时。那么,如何有效地索引训练样本以减少查询过程中所需的计算是一个重要的实际问题。

(2) 在从内存中检索相似的训练样例时,他们一般会考虑实例的所有属性。如果目标概念只依赖于其中的几个属性,那么最“相似”的示例很可能远分开。

二、k-最近邻法

最基本的基于案例的学习方法是k-最近邻算法。该算法假设所有实例都对应于 n 维欧几里得空间 n 中的点。实例的最近邻是根据标准欧几里德距离定义的。更准确地说,将任何实例 x 表示为以下特征向量:

a1(x), a2(x),..., an(x)

其中 ar(x) 表示实例 x 的第 r 个属性值。那么两个实例 xi 和 xj 之间的距离定义为 d(xi,xj),其中:

操作说明:

1、在最近邻学习中,目标函数值可以是离散值,也可以是实值。

2、我们首先考虑学习如下形式的离散目标函数

. 其中 V 是有限集 {v1,...vs}。下表显示了用于逼近离散目标函数的 k 最近邻算法。

3、 如下表所指出的,该算法的返回值f'(xq)是对f(xq)的估计,它是最接近xq的k个训练样例中最常见的f值。

4、 如果我们选择k=1,那么“1-近邻算法”将f(xi)分配给(xq),其中xi是最接近xq的训练实例。对于较大的 k 值,该算法返回前 k 个最接近的训练示例中最常见的 f 值。

近似离散值函数 f:ÂnV 的 _k-最近邻算法

训练算法:

对于每个训练示例,将此示例添加到列表 training___examples

分类算法:

给定一个待分类的查询实例 xq

在training___examples中选择最接近xq的k个实例并用x1....xk表示它们

返回

其中,若a=b则d(a,b)=1,否则d(a,b)=0。

下图以一个简单的例子说明了k-最近邻算法,例子是二维空间中的一个点,目标函数为布尔值。正负训练示例分别用“+”和“-”表示。图中还画了一个查询点xq。请注意,在该图中,1-最近邻算法将 xq 分类为正例,而 5-最近邻算法将 xq 分类为反例。

插图:左图显示了一系列正负训练示例和一个待分类的查询示例 xq。1-近邻算法将xq 分类为正例,而5-近邻算法将xq 分类为反例。

右图是针对一组典型的训练样例,1-最近邻算法导致的决策面。每个训练样例周围的凸多边形代表离该点最近的实例空间(即该空间中的实例将通过1-最近邻算法分配训练样例的分类)。

对前面的k-最近邻算法进行简单修改后,可以用来逼近一个连续值的目标函数。为了实现这一点,我们让算法计算 k 个最接近示例的平均值,而不是计算最常见的值。更准确地说,为了逼近一个实值目标函数

,我们只需要将算法中的公式替换为:

三、距离加权最近邻算法

k-最近邻算法的一个明显改进是对k个最近邻的贡献进行加权,并根据最近邻与查询点xq的距离为其分配更大的权重。

例如,在上表中逼近离散目标函数的算法中,我们可以根据每个邻居与xq的距离平方的倒数对每个邻居的“投票权”进行加权。

该方法是通过将上表算法中的公式替换为以下公式来实现的:

在

为了处理查询点 xq 与某个训练样例 xi 完全匹配,导致分母为 0 的情况,我们在这种情况下设置 f'(xq) 等于 f(xi)。如果有多个这样的训练示例,我们使用占大多数的分类。

我们也可以用类似的方式对实值目标函数进行加权,只要我们将上表中的公式替换为以下公式即可:

wi 的定义与前面的公式相同。

注意,这个公式中的分母是一个常数,它对不同权重的贡献进行了归一化(例如,它保证如果对于所有训练样例 xi,f(xi)=c,则 (xq)c)。

请注意,上述 k-最近邻算法的所有变体仅考虑 k 个最近邻来对查询点进行分类。如果使用按距离加权,实际上允许所有训练样例影响 xq 的分类是没有坏处的,因为很远的样例对 (xq) 的影响很小。考虑所有示例的唯一缺点是分类运行速度会更慢。如果在对新查询实例进行分类时考虑所有训练示例,我们称其为全局方法。如果只考虑最接近的训练示例,我们称其为本地方法。

四、 k-近邻算法解释

距离加权的k-最近邻算法是一种非常有效的归纳推理方法。它对训练数据中的噪声非常鲁棒,在给定足够大的训练集时也非常有效。注意,通过取k个最近邻的加权平均,可以消除孤立噪声样本的影响。

1、问题1:邻居之间的距离会被大量不相关的属性支配。

应用k-最近邻算法的一个实际问题是,实例之间的距离是根据实例的所有属性(即收录该实例的欧几里得空间的所有坐标轴)计算的。这与仅选择所有实例属性的子集的方法不同,例如决策树学习系统。

例如,这样一个问题:每个实例由 20 个属性描述,但其中只有 2 个属性与其分类相关。在这种情况下,这两个相关属性值相同的实例在这个20维的实例空间中可能相距很远。因此,依赖这 20 个属性的相似性度量会误导 k-近邻算法的分类。邻居之间的距离会被大量不相关的属性所支配。由于存在许多不相关的属性而导致的这个问题有时被称为维度灾难(curse of Dimensionity)。最近邻法对这个问题特别敏感。

2、解决方案:计算两个实例之间的距离时对每个属性进行加权。

这相当于在欧几里德空间中缩放坐标轴,缩短相关性较低的属性对应的坐标轴,延长相关性较高的属性对应的坐标轴。每个坐标轴应该拉伸的量可以通过交叉验证的方法自动确定。

3、问题2:应用k-最近邻算法的另一个实际问题是如何建立一个高效的索引。由于此算法将所有处理推迟到接收到新查询之前,因此处理每个新查询可能需要进行大量计算。

4、 解决方案:目前已经开发了很多方法来索引存储的训练示例,以便在存储开销有一定增加的情况下更有效地确定最近邻。一种索引方法是kd-tree(Bentley 1975; Friedman et al. 1977),它将实例存储在树的叶节点中,相邻的实例存储在相同或附近的节点中。通过来测试所选的新查询 xq 的属性,树的内部节点将查询 xq 排列到相关的叶节点。

机器学习与数据挖掘-K最近邻(KNN)算法实现(java和python版)

免规则采集器列表算法(大众点评商家详情页数据采集图4步骤3:采集详情页)

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-12-13 02:25

大众点评 大众点评商户详情页数据采集图4

第三步:采集详情页数据

选择需要点击的商家名称,创建重复点击列表

进入详情页创建采集列表

1)如图,移动鼠标选中列表中的商家名称,点击右键,采集的内容会变成绿色,然后点击“全选"

大众点评 大众点评商户详情页数据采集图5

注意:点击右上角的“处理”按钮,会显示一个可视化的流程图。

2)然后点击“点击循环中的每个元素”

大众点评 大众点评商户详情页数据采集图6

3)网页会跳转到详情页,在详情页移动鼠标选择商户名称,选择“采集该元素的文字”

大众点评 大众点评商户详情页数据采集图7

4) 右击每个需要采集的文本域,然后点击“采集以下数据”

大众点评 大众点评商户详情页数据采集图8

5) 修改采集字段名称,点击下方红框中的“保存并启动采集”

大众点评 大众点评商户详情页数据采集图9

6)根据采集的情况选择合适的采集方式,这里选择“启动本地采集”

大众点评 大众点评商户详情页数据采集图10

说明:本地采集为采集占用当前计算机资源,如果有采集时间要求或当前计算机长时间无法执行采集可以使用cloud采集功能,Cloud采集网络上采集,不需要当前电脑支持,电脑可以关机,可以设置多个云节点共享任务,10个节点相当于10台电脑分配任务帮你采集,速度降低到原来速度的十分之一; 采集收到的数据可以在云端存储三个月,随时可以导出。

第四步:数据采集和导出

1)采集完成后,选择合适的导出方式,导出采集好的数据

大众点评 大众点评业务详情页数据采集图11

优采云——70万用户选择的网页数据采集器。

1、操作简单,任何人都可以使用:无需技术背景,即可上网采集。过程完全可视化,点击鼠标即可完成操作,2分钟即可快速上手。 查看全部

免规则采集器列表算法(大众点评商家详情页数据采集图4步骤3:采集详情页)

大众点评 大众点评商户详情页数据采集图4

第三步:采集详情页数据

选择需要点击的商家名称,创建重复点击列表

进入详情页创建采集列表

1)如图,移动鼠标选中列表中的商家名称,点击右键,采集的内容会变成绿色,然后点击“全选"

大众点评 大众点评商户详情页数据采集图5

注意:点击右上角的“处理”按钮,会显示一个可视化的流程图。

2)然后点击“点击循环中的每个元素”

大众点评 大众点评商户详情页数据采集图6

3)网页会跳转到详情页,在详情页移动鼠标选择商户名称,选择“采集该元素的文字”

大众点评 大众点评商户详情页数据采集图7

4) 右击每个需要采集的文本域,然后点击“采集以下数据”

大众点评 大众点评商户详情页数据采集图8

5) 修改采集字段名称,点击下方红框中的“保存并启动采集”

大众点评 大众点评商户详情页数据采集图9

6)根据采集的情况选择合适的采集方式,这里选择“启动本地采集”

大众点评 大众点评商户详情页数据采集图10

说明:本地采集为采集占用当前计算机资源,如果有采集时间要求或当前计算机长时间无法执行采集可以使用cloud采集功能,Cloud采集网络上采集,不需要当前电脑支持,电脑可以关机,可以设置多个云节点共享任务,10个节点相当于10台电脑分配任务帮你采集,速度降低到原来速度的十分之一; 采集收到的数据可以在云端存储三个月,随时可以导出。

第四步:数据采集和导出

1)采集完成后,选择合适的导出方式,导出采集好的数据

大众点评 大众点评业务详情页数据采集图11

优采云——70万用户选择的网页数据采集器。

1、操作简单,任何人都可以使用:无需技术背景,即可上网采集。过程完全可视化,点击鼠标即可完成操作,2分钟即可快速上手。

免规则采集器列表算法(【T·每日一练】2016年10月21日)

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-12-10 18:31

第一章1、麦肯锡研究院2011年提出的大数据定义是:大数据是指规模超过常规数据库工具获取、存储、管理和()能力的数据集。A:计算B:访问C:应用D:分析答案:分析2、如果用4V来概括大数据的特征,一般指的是:Value、Velocity、Volume和()。A:Variety B:Vainly C:Vagary D:Valley 答案:Variety 3、 大数据分析的四个方面主要是:数据分类、()、关联规则挖掘和时间序列预测。A:数据统计 B:数据计算 C:数据聚类 D:数据清洗 答:数据聚类4、新浪和京东联合推出的大数据产品推荐,是京东盲目推的。com 给当前浏览新浪网站的用户 页面。A:正确 B:错误 答案:错误 5、 目前的大数据处理技术只能处理结构化数据。A:正确 B:错误 答案:错误 第二章 1、 我们常用的 Microsoft Office 套件中 Access 数据库软件的数据库文件格式的后缀是 ()。A:mdf B:mdb C:dbf D:xls 答案:mdb 2、 大多数日志文件的后缀是 ()。A:txt B:csv C:xml D:log 答:log 3、 本课程重点介绍的weka软件的专有文件格式是()。我们常用的Microsoft Office套件中Access数据库软件的数据库文件格式的后缀是()。A:mdf B:mdb C:dbf D:xls 答案:mdb 2、 大多数日志文件的后缀是 ()。A:txt B:csv C:xml D:log 答:log 3、 本课程重点介绍的weka软件的专有文件格式是()。我们常用的Microsoft Office套件中Access数据库软件的数据库文件格式的后缀是()。A:mdf B:mdb C:dbf D:xls 答案:mdb 2、 大多数日志文件的后缀是 ()。A:txt B:csv C:xml D:log 答:log 3、 本课程重点介绍的weka软件的专有文件格式是()。

A:MongoDB B:ARFF C:value D:key map 答案:ARFF 4、 数据清洗的目的主要是解决数据的完整性、唯一性、合法性和()。A:专业性 B:排他性 C:一致性 D:共享性 答:一致性5、优采云 在软件的“自定义采集”工作模式下,需要在软件中输入一个( ) 作为 采集 的目标出现。A:电话号码 B:关键词 C:网址 D:用户名 答:网址 6、优采云本软件采集规则可以通过以下方式导入或导出files ,这种文件的后缀是 ()。A:otd B:jpg C:png D:gif 答案:otd 7、Excel 可以通过操作“数据有效性”按钮来调节数据输入的范围。A:正确 B:错误 答案:是 8、 Excel 无法导入 txt 或 csv 格式的文件。A:正确 B:错误 答案:错误 9、优采云 本软件只能用于网站采集内置“简单采集”的数据“ 规则。A:正确 B:错误 答案:错误 10、优采云定制软件时采集,需要了解网页的页面结构。A:正确 B:错误答案:使用 DBSCAN 算法对第 3 章 1、 中的虹膜数据集(Iris.arff)进行聚类,将 epsilon 参数设置为 0.2,将 minPoints 参数设置为 5。忽略class 属性,则 () 簇将形成。A:正确 B:错误 答案:错误 10、优采云定制软件时采集,需要了解网页的页面结构。A:正确 B:错误答案:使用DBSCAN算法对第三章1、中的虹膜数据集(Iris.arff)进行聚类,设置epsilon参数为0.2,minPoints参数为5。忽略class 属性,则 () 簇将形成。A:正确 B:错误 答案:错误 10、优采云定制软件时采集,需要了解网页的页面结构。A:正确 B:错误答案:使用 DBSCAN 算法对第 3 章 1、 中的虹膜数据集(Iris.arff)进行聚类,将 epsilon 参数设置为 0.2,将 minPoints 参数设置为 5。忽略class 属性,则 () 簇将形成。

A: 1 B: 2 C: 3 D: 4 答案:3 2、 使用EM算法对天气数据集(weather.numeric.arff)进行聚类,设置numClusters为4,即聚类数4.其他参数保持默认值,忽略class属性。从结果可以看出,在以下选项中,()是错误的。A:模型的最大似然估计为-7.18 B:这组数据用算法迭代15次 C:第四个聚类的先验概率为0.14 D:第四个cluster 的实例数为4 答:第四个cluster的实例数为4 3、 使用SimpleKMeans算法对天气数据集(weather.numeric.arff)进行聚类,保持默认参数,即3 个集群和欧几里得距离。选择播放属性作为忽略属性。从结果可以看出,在以下选项中,()是错误的。A:这组数据被算法迭代了四次。B:产生三个中心点。C:聚合成 3 个集群,分别有 7、3 和 4 个实例。D:平方和的误差为8.928 答:这个组数据用算法4、迭代四次,使用线性回归(LinearRegression)分类器和M5P分类器对cpu进行分类。 arff,输出误差指数可以知道()。A:LinearRegression的标准误差比M5P小。B:LinearRegression 的平均绝对误差小于 M5P。C:LinearRegression的相对误差比M5P小。D:LinearRegression 的平均根误差小于 M5P 的平均值。平方根误差很大。答案:LinearRegression的平均平方根误差比M5P大。5、删除cpu.arff数据文件中的CACH属性后,使用M5P分类器构建方案。有 () 个 LM2 实例。

A: 165 B: 21 C: 23 D: 30 Answer: 21 6、 当outlook=sunny时,根据J48分类器训练weather.nominal.arff产生的决策树;温度=凉爽;湿度=高;windy =TRUE,分类结果为()。A:是 B:否 C:没有结果 D:无法分类 答案:否 7、 根据 J48 分类器训练 iris.arff 产生的决策树,当 sepallength=4.4; 查看全部

免规则采集器列表算法(【T·每日一练】2016年10月21日)

第一章1、麦肯锡研究院2011年提出的大数据定义是:大数据是指规模超过常规数据库工具获取、存储、管理和()能力的数据集。A:计算B:访问C:应用D:分析答案:分析2、如果用4V来概括大数据的特征,一般指的是:Value、Velocity、Volume和()。A:Variety B:Vainly C:Vagary D:Valley 答案:Variety 3、 大数据分析的四个方面主要是:数据分类、()、关联规则挖掘和时间序列预测。A:数据统计 B:数据计算 C:数据聚类 D:数据清洗 答:数据聚类4、新浪和京东联合推出的大数据产品推荐,是京东盲目推的。com 给当前浏览新浪网站的用户 页面。A:正确 B:错误 答案:错误 5、 目前的大数据处理技术只能处理结构化数据。A:正确 B:错误 答案:错误 第二章 1、 我们常用的 Microsoft Office 套件中 Access 数据库软件的数据库文件格式的后缀是 ()。A:mdf B:mdb C:dbf D:xls 答案:mdb 2、 大多数日志文件的后缀是 ()。A:txt B:csv C:xml D:log 答:log 3、 本课程重点介绍的weka软件的专有文件格式是()。我们常用的Microsoft Office套件中Access数据库软件的数据库文件格式的后缀是()。A:mdf B:mdb C:dbf D:xls 答案:mdb 2、 大多数日志文件的后缀是 ()。A:txt B:csv C:xml D:log 答:log 3、 本课程重点介绍的weka软件的专有文件格式是()。我们常用的Microsoft Office套件中Access数据库软件的数据库文件格式的后缀是()。A:mdf B:mdb C:dbf D:xls 答案:mdb 2、 大多数日志文件的后缀是 ()。A:txt B:csv C:xml D:log 答:log 3、 本课程重点介绍的weka软件的专有文件格式是()。

A:MongoDB B:ARFF C:value D:key map 答案:ARFF 4、 数据清洗的目的主要是解决数据的完整性、唯一性、合法性和()。A:专业性 B:排他性 C:一致性 D:共享性 答:一致性5、优采云 在软件的“自定义采集”工作模式下,需要在软件中输入一个( ) 作为 采集 的目标出现。A:电话号码 B:关键词 C:网址 D:用户名 答:网址 6、优采云本软件采集规则可以通过以下方式导入或导出files ,这种文件的后缀是 ()。A:otd B:jpg C:png D:gif 答案:otd 7、Excel 可以通过操作“数据有效性”按钮来调节数据输入的范围。A:正确 B:错误 答案:是 8、 Excel 无法导入 txt 或 csv 格式的文件。A:正确 B:错误 答案:错误 9、优采云 本软件只能用于网站采集内置“简单采集”的数据“ 规则。A:正确 B:错误 答案:错误 10、优采云定制软件时采集,需要了解网页的页面结构。A:正确 B:错误答案:使用 DBSCAN 算法对第 3 章 1、 中的虹膜数据集(Iris.arff)进行聚类,将 epsilon 参数设置为 0.2,将 minPoints 参数设置为 5。忽略class 属性,则 () 簇将形成。A:正确 B:错误 答案:错误 10、优采云定制软件时采集,需要了解网页的页面结构。A:正确 B:错误答案:使用DBSCAN算法对第三章1、中的虹膜数据集(Iris.arff)进行聚类,设置epsilon参数为0.2,minPoints参数为5。忽略class 属性,则 () 簇将形成。A:正确 B:错误 答案:错误 10、优采云定制软件时采集,需要了解网页的页面结构。A:正确 B:错误答案:使用 DBSCAN 算法对第 3 章 1、 中的虹膜数据集(Iris.arff)进行聚类,将 epsilon 参数设置为 0.2,将 minPoints 参数设置为 5。忽略class 属性,则 () 簇将形成。

A: 1 B: 2 C: 3 D: 4 答案:3 2、 使用EM算法对天气数据集(weather.numeric.arff)进行聚类,设置numClusters为4,即聚类数4.其他参数保持默认值,忽略class属性。从结果可以看出,在以下选项中,()是错误的。A:模型的最大似然估计为-7.18 B:这组数据用算法迭代15次 C:第四个聚类的先验概率为0.14 D:第四个cluster 的实例数为4 答:第四个cluster的实例数为4 3、 使用SimpleKMeans算法对天气数据集(weather.numeric.arff)进行聚类,保持默认参数,即3 个集群和欧几里得距离。选择播放属性作为忽略属性。从结果可以看出,在以下选项中,()是错误的。A:这组数据被算法迭代了四次。B:产生三个中心点。C:聚合成 3 个集群,分别有 7、3 和 4 个实例。D:平方和的误差为8.928 答:这个组数据用算法4、迭代四次,使用线性回归(LinearRegression)分类器和M5P分类器对cpu进行分类。 arff,输出误差指数可以知道()。A:LinearRegression的标准误差比M5P小。B:LinearRegression 的平均绝对误差小于 M5P。C:LinearRegression的相对误差比M5P小。D:LinearRegression 的平均根误差小于 M5P 的平均值。平方根误差很大。答案:LinearRegression的平均平方根误差比M5P大。5、删除cpu.arff数据文件中的CACH属性后,使用M5P分类器构建方案。有 () 个 LM2 实例。

A: 165 B: 21 C: 23 D: 30 Answer: 21 6、 当outlook=sunny时,根据J48分类器训练weather.nominal.arff产生的决策树;温度=凉爽;湿度=高;windy =TRUE,分类结果为()。A:是 B:否 C:没有结果 D:无法分类 答案:否 7、 根据 J48 分类器训练 iris.arff 产生的决策树,当 sepallength=4.4;

免规则采集器列表算法(百度石榴算法的原理是什么?百度绿萝算法怎么做)

采集交流 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2021-12-08 04:13

一、百度算法规则

之前很多人都不相信百度的算法有那么神奇,但百度确实对这一系列算法进行了公告和K站降级。他们必须仔细分析百度算法的原理。现在让我们一起来。一探究竟!

百度绿萝算法:

我从来不相信百度的绿萝算法可以计算你的链接是否被购买,但百度确实做到了。主要原理是判断一个网站和另一个网站之间是否存在负联系。判断链接和链接数。

百度石榴算法:

石榴算法主要针对低质量页面,其中百度蜘蛛主要根据网站html代码抓取,搜索引擎根据文章的标签进行判断(包括排版)并反复阅读。网站 的质量。

百度星火项目:

Spark 项目的最初计划是打击抄袭。Spark Project的原理很简单,就是通过反复阅读判断网站是否抄袭。同时,百度蜘蛛也确认了自己的爬虫程序。每一个 网站 总是爬得更近。

二、百度收录规则

要想有排名,前提是收录,如果要投稿,前提是收录,有内容,这么多网站内容太单一了很难成为收录,但也有网站 显然有内容但没有收录;

1、 抓取:

百度收录一个网站或者页面的前提是网站已经被百度抓取过,也就是百度的机器已经到了你的站点,来到你站点的前提是有一个入口,百度有三个入口点,第一个自我提交,第二个SEO外链,第三个浏览器。浏览器可能不是每个人都非常清楚。当你的网站刚刚建立的时候,没有人知道你的网站建立了。百度自然不会知道。唯一知道的就是你自己。如果你用百度浏览在浏览器中打开你的网站,说明百度浏览器已经知道该站点的存在,将数据交给百度搜索引擎,达到爬取的效果。Scrape还不够,不是所有的内容都会被百度收录,

2、身份:

我抓了一个页面,它必须有内容。如果没有内容,就很难成为收录。什么是没有内容的页面,比如登录和注册页面。这种类型的页面对内容毫无意义。页。它将直接列在空白页上。对于这种类型的页面,我们的网站还是非常多的,比如:关于我们,联系我们等页面。

因此,页面必须有内容并且是可识别的内容。可识别的内容是文本内容。百度搜索引擎被机器识别。当他们遇到视频、图片和flash时,他们不知道视频和图片。里面显示的是什么,所以无法识别,所以最好在前期专注于文字。

3、发布:

最后,考虑发布。如果发布了,此时你可以通过百度搜索你的网址。您的页面的发布也需要有条件。

首先会判断你的页面有很多站外推荐,说明这个页面是会被站外推荐的优质页面,很容易被收录 ,其次是网站推荐的,这也意味着只有高质量的页面才会被网站推荐。说白了,要发布的内容绝对是优质内容,除非出现以下情况。

最有可能是收录的内容肯定是互联网新闻来源最多的内容。说白了,抄袭多的内容最容易成为收录。这个时候,太多的人并不容易理解。越抄袭越容易被收录?

新闻内容具有时效性。一篇新闻文章发布后,会有很多媒体转载你的内容,百度机器已经识别出很多新闻来源有相同的内容,都会被收录到新闻主题页面中。所以收录这方面的内容很简单。你不会在 收录 之前等待一天或几天。如果只是几天后,收录,这个新闻内容已经过时了,自然也影响了百度的体验。

三、百度排名规则

参与排名的规则并没有想象中的那么复杂。我认为它们具有一定的价值。其实他们无非是在几个方面解决排名问题。

1、评分规则:

评分规则基于网站的整体声誉,例如网站的原创度,网站的停留时间,网站的跳出率, 网站打开速度、网站图片处理、网站代码优化等综合判断统称为评分规则。

2、点击规则:

当你的网站声望达到基本标准时,你的网站会有一些很长的尾巴关键词,可能关键词排名不在首页,这次是根据点击率规则用于计算排名。

3、链接规则:

当你的文章文章被站外链接推荐太多时,说明这篇文章文章很有价值,否则对方不会推荐,而且在站内也被多次推荐网站,也就是这个文章的价值很高,所以链接规则很简单,但是百度的露洛算法一直在对抗垃圾外链,所以最好使用自然链接更安全说到链接。 查看全部

免规则采集器列表算法(百度石榴算法的原理是什么?百度绿萝算法怎么做)

一、百度算法规则

之前很多人都不相信百度的算法有那么神奇,但百度确实对这一系列算法进行了公告和K站降级。他们必须仔细分析百度算法的原理。现在让我们一起来。一探究竟!

百度绿萝算法:

我从来不相信百度的绿萝算法可以计算你的链接是否被购买,但百度确实做到了。主要原理是判断一个网站和另一个网站之间是否存在负联系。判断链接和链接数。

百度石榴算法:

石榴算法主要针对低质量页面,其中百度蜘蛛主要根据网站html代码抓取,搜索引擎根据文章的标签进行判断(包括排版)并反复阅读。网站 的质量。

百度星火项目:

Spark 项目的最初计划是打击抄袭。Spark Project的原理很简单,就是通过反复阅读判断网站是否抄袭。同时,百度蜘蛛也确认了自己的爬虫程序。每一个 网站 总是爬得更近。

二、百度收录规则

要想有排名,前提是收录,如果要投稿,前提是收录,有内容,这么多网站内容太单一了很难成为收录,但也有网站 显然有内容但没有收录;

1、 抓取:

百度收录一个网站或者页面的前提是网站已经被百度抓取过,也就是百度的机器已经到了你的站点,来到你站点的前提是有一个入口,百度有三个入口点,第一个自我提交,第二个SEO外链,第三个浏览器。浏览器可能不是每个人都非常清楚。当你的网站刚刚建立的时候,没有人知道你的网站建立了。百度自然不会知道。唯一知道的就是你自己。如果你用百度浏览在浏览器中打开你的网站,说明百度浏览器已经知道该站点的存在,将数据交给百度搜索引擎,达到爬取的效果。Scrape还不够,不是所有的内容都会被百度收录,

2、身份:

我抓了一个页面,它必须有内容。如果没有内容,就很难成为收录。什么是没有内容的页面,比如登录和注册页面。这种类型的页面对内容毫无意义。页。它将直接列在空白页上。对于这种类型的页面,我们的网站还是非常多的,比如:关于我们,联系我们等页面。

因此,页面必须有内容并且是可识别的内容。可识别的内容是文本内容。百度搜索引擎被机器识别。当他们遇到视频、图片和flash时,他们不知道视频和图片。里面显示的是什么,所以无法识别,所以最好在前期专注于文字。

3、发布:

最后,考虑发布。如果发布了,此时你可以通过百度搜索你的网址。您的页面的发布也需要有条件。

首先会判断你的页面有很多站外推荐,说明这个页面是会被站外推荐的优质页面,很容易被收录 ,其次是网站推荐的,这也意味着只有高质量的页面才会被网站推荐。说白了,要发布的内容绝对是优质内容,除非出现以下情况。

最有可能是收录的内容肯定是互联网新闻来源最多的内容。说白了,抄袭多的内容最容易成为收录。这个时候,太多的人并不容易理解。越抄袭越容易被收录?

新闻内容具有时效性。一篇新闻文章发布后,会有很多媒体转载你的内容,百度机器已经识别出很多新闻来源有相同的内容,都会被收录到新闻主题页面中。所以收录这方面的内容很简单。你不会在 收录 之前等待一天或几天。如果只是几天后,收录,这个新闻内容已经过时了,自然也影响了百度的体验。

三、百度排名规则

参与排名的规则并没有想象中的那么复杂。我认为它们具有一定的价值。其实他们无非是在几个方面解决排名问题。

1、评分规则:

评分规则基于网站的整体声誉,例如网站的原创度,网站的停留时间,网站的跳出率, 网站打开速度、网站图片处理、网站代码优化等综合判断统称为评分规则。

2、点击规则:

当你的网站声望达到基本标准时,你的网站会有一些很长的尾巴关键词,可能关键词排名不在首页,这次是根据点击率规则用于计算排名。

3、链接规则:

当你的文章文章被站外链接推荐太多时,说明这篇文章文章很有价值,否则对方不会推荐,而且在站内也被多次推荐网站,也就是这个文章的价值很高,所以链接规则很简单,但是百度的露洛算法一直在对抗垃圾外链,所以最好使用自然链接更安全说到链接。

免规则采集器列表算法( 基于Chromium开放源代码项目开发(版本:Chromium66)(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-12-07 16:20

基于Chromium开放源代码项目开发(版本:Chromium66)(组图))

秘密消息浏览器

密信浏览器是基于chromium开源项目开发的(版本:chromium 66),主要增加对国家机密算法SM2/SM3/SM4的支持,支持国家机密SSL证书,同时修改SSL证书显示界面,使用V1/V2/V3/V4标识标识不同类型的SSL证书(DV/IV/OV/EV)

密信浏览器遵循国家标准GM/T 0024-2014:SSL VPN技术规范,支持国家秘密算法:非对称算法:SM2算法、对称算法:SM4算法、哈希算法(抽象算法):SM3算法,密信浏览器支持USBKEY国家秘密证书,采用标准SKF接口实现双向认证(强身份认证)

密信浏览器不仅支持SM2国家秘密算法和国家秘密SSL证书,还支持国际标准中的各种加密算法和RSA/eccssl证书,确保用户能够正常访问仅支持国家秘密算法的网站和仅支持intern的网站国家标准算法。如果用户网站同时部署国家机密SSL证书和rsassl证书,则密信浏览器优先选择国家机密算法,实现HTTPS加密传输

密信浏览器跟随密信应用程序(加密电子邮件客户端)根据证书显示界面的规则,扩展单元认证的evssl证书显示为安全锁、V4标识和单元名称,并显示绿色地址栏;标准单元认证的OV SSL证书显示为安全锁、V3标识和单元名称,以及白色地址栏;个人认证的ivssl证书显示为安全锁、V2标识和个人名称,白色地址栏:仅验证域名所有权的DV SSL证书显示为安全锁、V1标识和白色地址栏;而网站不显示SSL证书显示为“不安全”

RSA EV SSL证书:

国家机密SM2 V4 SSL证书:

RSA ov SSL证书:

国家机密SM2 V3 SSL证书:

RSA IV SSL证书:

RSA DV SSL证书:

网站未部署SSL证书:

密信浏览器非常重视网站真实身份的认证和显示。由第三方CA认证的网站身份是一个受信任的身份。此网站的身份信息必须清晰显示,以防用户受骗。但是,一些浏览器仅单方面emphasize encryption并忽略身份的重要性,这使得许多欺诈网站部署未经验证的身份dvssl证书旨在让用户认为它是安全和可信的

目前,密信浏览器尚未提供信任根身份验证计划。Windows版本的密信浏览器信任Windows“受信任根证书颁发机构”以及watcom ca的所有RSA根证书和国家机密根证书

欢迎使用密信浏览器的Windows版本。我们将在适当的时候推出其他操作系统版本。请期待。谢谢 查看全部

免规则采集器列表算法(

基于Chromium开放源代码项目开发(版本:Chromium66)(组图))

秘密消息浏览器

密信浏览器是基于chromium开源项目开发的(版本:chromium 66),主要增加对国家机密算法SM2/SM3/SM4的支持,支持国家机密SSL证书,同时修改SSL证书显示界面,使用V1/V2/V3/V4标识标识不同类型的SSL证书(DV/IV/OV/EV)

密信浏览器遵循国家标准GM/T 0024-2014:SSL VPN技术规范,支持国家秘密算法:非对称算法:SM2算法、对称算法:SM4算法、哈希算法(抽象算法):SM3算法,密信浏览器支持USBKEY国家秘密证书,采用标准SKF接口实现双向认证(强身份认证)

密信浏览器不仅支持SM2国家秘密算法和国家秘密SSL证书,还支持国际标准中的各种加密算法和RSA/eccssl证书,确保用户能够正常访问仅支持国家秘密算法的网站和仅支持intern的网站国家标准算法。如果用户网站同时部署国家机密SSL证书和rsassl证书,则密信浏览器优先选择国家机密算法,实现HTTPS加密传输

密信浏览器跟随密信应用程序(加密电子邮件客户端)根据证书显示界面的规则,扩展单元认证的evssl证书显示为安全锁、V4标识和单元名称,并显示绿色地址栏;标准单元认证的OV SSL证书显示为安全锁、V3标识和单元名称,以及白色地址栏;个人认证的ivssl证书显示为安全锁、V2标识和个人名称,白色地址栏:仅验证域名所有权的DV SSL证书显示为安全锁、V1标识和白色地址栏;而网站不显示SSL证书显示为“不安全”

RSA EV SSL证书:

国家机密SM2 V4 SSL证书:

RSA ov SSL证书:

国家机密SM2 V3 SSL证书:

RSA IV SSL证书:

RSA DV SSL证书:

网站未部署SSL证书:

密信浏览器非常重视网站真实身份的认证和显示。由第三方CA认证的网站身份是一个受信任的身份。此网站的身份信息必须清晰显示,以防用户受骗。但是,一些浏览器仅单方面emphasize encryption并忽略身份的重要性,这使得许多欺诈网站部署未经验证的身份dvssl证书旨在让用户认为它是安全和可信的

目前,密信浏览器尚未提供信任根身份验证计划。Windows版本的密信浏览器信任Windows“受信任根证书颁发机构”以及watcom ca的所有RSA根证书和国家机密根证书

欢迎使用密信浏览器的Windows版本。我们将在适当的时候推出其他操作系统版本。请期待。谢谢

免规则采集器列表算法(算法代码主要在CMT这个类里面主要包含initialize和processFrame两个函数)

采集交流 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-12-06 09:18

cmt 算法 cmt 算法

代码主要在CMT类中,主要包括initialize和processFrame函数的实现。它非常适合纸张。我会评论每个成员的所作所为。

点击打开代码下载链接

namespace cmt

{

class CMT

{

public:

CMT() : str_detector("FAST"), str_descriptor("BRISK") {} //默认的特征检测和描述子

void initialize(const Mat im_gray, const Rect rect); //rect是初始目标框

void processFrame(const Mat im_gray);

Fusion fusion;//跟踪点融合:融合跟踪和匹配的点 将两种点都放在一起,并且不重复

Matcher matcher; //DescriptorMatcher 用的knnMatch匹配

Tracker tracker; //光溜匹配跟踪 上一帧的特征点使用光流法跟踪得到这一帧的特征点的位置T

Consensus consensus;//包括scale和rotation angel的求取和对目标中心的投票

string str_detector;

string str_descriptor;

vector points_active; //public for visualization purposes

RotatedRect bb_rot;

private:

Ptr detector;

Ptr descriptor;

Size2f size_initial;

vector classes_active; //forgroud points -in target boundingboxs

float theta;

Mat im_prev;

};

} /* namespace CMT */

最重要的跟踪实施过程:

初始代码实现,添加注释:

void CMT::initialize(const Mat im_gray, const Rect rect)

{

//Remember initial size

size_initial = rect.size();

//Remember initial image

im_prev = im_gray;

//Compute center of rect

Point2f center = Point2f(rect.x + rect.width/2.0, rect.y + rect.height/2.0);

//Initialize rotated bounding box

bb_rot = RotatedRect(center, size_initial, 0.0);

//Initialize detector and descriptor

//FeatureDetector is OpenCVs feature detector,including "FAST","ORB","SIFT"

//"STAR",MSER","GFTT","HARRIS","Dense","SimpleBlob"

detector = FeatureDetector::create(str_detector);//FAST

descriptor = DescriptorExtractor::create(str_descriptor);//BRISK

//Get initial keypoints in whole image and compute their descriptors

vector keypoints;

detector->detect(im_gray, keypoints);

//Divide keypoints into foreground and background keypoints according to selection

//in target bounding box is foreground

vector keypoints_fg;

vector keypoints_bg;

for (size_t i = 0; i < keypoints.size(); i++)

{

KeyPoint k = keypoints[i];

Point2f pt = k.pt;

if (pt.x > rect.x && pt.y > rect.y && pt.x < rect.br().x && pt.y < rect.br().y)

{

keypoints_fg.push_back(k);

}

else

{

keypoints_bg.push_back(k);

}

}

//Create foreground classes

vector classes_fg;

classes_fg.reserve(keypoints_fg.size());

for (size_t i = 0; i < keypoints_fg.size(); i++)

{

classes_fg.push_back(i);

}

//Compute foreground/background features

Mat descs_fg;

Mat descs_bg;

descriptor->compute(im_gray, keypoints_fg, descs_fg);

descriptor->compute(im_gray, keypoints_bg, descs_bg);

//Only now is the right time to convert keypoints to points, as compute() might remove some keypoints

vector points_fg;

vector points_bg;

for (size_t i = 0; i < keypoints_fg.size(); i++)

{

points_fg.push_back(keypoints_fg[i].pt);

}

for (size_t i = 0; i < keypoints_bg.size(); i++)

{

points_bg.push_back(keypoints_bg[i].pt);

}

//Create normalized points: distance to center

vector points_normalized;

for (size_t i = 0; i < points_fg.size(); i++)

{

points_normalized.push_back(points_fg[i] - center);

}

//Initialize matcher

matcher.initialize(points_normalized, descs_fg, classes_fg, descs_bg, center);

//Initialize consensus get Xi,Xj distance and angle

consensus.initialize(points_normalized);

//Create initial set of active keypoints

for (size_t i = 0; i < keypoints_fg.size(); i++)

{

points_active.push_back(keypoints_fg[i].pt);

classes_active = classes_fg;

}

}

总结:这是一种基于特征点匹配的跟踪算法。创新之处在于它利用特征点相对距离的投票来确定目标位置。优点是对于没有变形的物体,无论物体如何移动或旋转,上述特征点到中心的距离都是在缩放比例下确定的。

作者在论文中说:CMT背后的主要思想是将感兴趣的对象分解成微小的部分,称为关键点。在每一帧中,我们尝试再次找到已经在初始选择中的关键点感兴趣的对象。我们通过使用两种不同的方法来做到这一点。首先,我们通过估计所谓的光流来跟踪从前一帧到当前帧的关键点。其次,我们通过比较它们的描述符来全局匹配关键点。这些方法容易出错,我们采用了一种新颖的方式,通过让每个关键点投票给对象中心来在找到的关键点内寻找共识,如下图所示:

然后通过对中心集群进行投票来确定中心位置: 查看全部

免规则采集器列表算法(算法代码主要在CMT这个类里面主要包含initialize和processFrame两个函数)

cmt 算法 cmt 算法

代码主要在CMT类中,主要包括initialize和processFrame函数的实现。它非常适合纸张。我会评论每个成员的所作所为。

点击打开代码下载链接

namespace cmt

{

class CMT

{

public:

CMT() : str_detector("FAST"), str_descriptor("BRISK") {} //默认的特征检测和描述子

void initialize(const Mat im_gray, const Rect rect); //rect是初始目标框

void processFrame(const Mat im_gray);

Fusion fusion;//跟踪点融合:融合跟踪和匹配的点 将两种点都放在一起,并且不重复

Matcher matcher; //DescriptorMatcher 用的knnMatch匹配

Tracker tracker; //光溜匹配跟踪 上一帧的特征点使用光流法跟踪得到这一帧的特征点的位置T

Consensus consensus;//包括scale和rotation angel的求取和对目标中心的投票

string str_detector;

string str_descriptor;

vector points_active; //public for visualization purposes

RotatedRect bb_rot;

private:

Ptr detector;

Ptr descriptor;

Size2f size_initial;

vector classes_active; //forgroud points -in target boundingboxs

float theta;

Mat im_prev;

};

} /* namespace CMT */

最重要的跟踪实施过程:

初始代码实现,添加注释:

void CMT::initialize(const Mat im_gray, const Rect rect)

{

//Remember initial size

size_initial = rect.size();

//Remember initial image

im_prev = im_gray;

//Compute center of rect

Point2f center = Point2f(rect.x + rect.width/2.0, rect.y + rect.height/2.0);

//Initialize rotated bounding box

bb_rot = RotatedRect(center, size_initial, 0.0);

//Initialize detector and descriptor

//FeatureDetector is OpenCVs feature detector,including "FAST","ORB","SIFT"

//"STAR",MSER","GFTT","HARRIS","Dense","SimpleBlob"

detector = FeatureDetector::create(str_detector);//FAST

descriptor = DescriptorExtractor::create(str_descriptor);//BRISK

//Get initial keypoints in whole image and compute their descriptors

vector keypoints;

detector->detect(im_gray, keypoints);

//Divide keypoints into foreground and background keypoints according to selection

//in target bounding box is foreground

vector keypoints_fg;

vector keypoints_bg;

for (size_t i = 0; i < keypoints.size(); i++)

{

KeyPoint k = keypoints[i];

Point2f pt = k.pt;

if (pt.x > rect.x && pt.y > rect.y && pt.x < rect.br().x && pt.y < rect.br().y)

{

keypoints_fg.push_back(k);

}

else

{

keypoints_bg.push_back(k);

}

}

//Create foreground classes

vector classes_fg;

classes_fg.reserve(keypoints_fg.size());

for (size_t i = 0; i < keypoints_fg.size(); i++)

{

classes_fg.push_back(i);

}

//Compute foreground/background features

Mat descs_fg;

Mat descs_bg;

descriptor->compute(im_gray, keypoints_fg, descs_fg);

descriptor->compute(im_gray, keypoints_bg, descs_bg);

//Only now is the right time to convert keypoints to points, as compute() might remove some keypoints

vector points_fg;

vector points_bg;

for (size_t i = 0; i < keypoints_fg.size(); i++)

{

points_fg.push_back(keypoints_fg[i].pt);

}

for (size_t i = 0; i < keypoints_bg.size(); i++)

{

points_bg.push_back(keypoints_bg[i].pt);

}

//Create normalized points: distance to center

vector points_normalized;

for (size_t i = 0; i < points_fg.size(); i++)

{

points_normalized.push_back(points_fg[i] - center);

}

//Initialize matcher

matcher.initialize(points_normalized, descs_fg, classes_fg, descs_bg, center);

//Initialize consensus get Xi,Xj distance and angle

consensus.initialize(points_normalized);

//Create initial set of active keypoints

for (size_t i = 0; i < keypoints_fg.size(); i++)

{

points_active.push_back(keypoints_fg[i].pt);

classes_active = classes_fg;

}

}

总结:这是一种基于特征点匹配的跟踪算法。创新之处在于它利用特征点相对距离的投票来确定目标位置。优点是对于没有变形的物体,无论物体如何移动或旋转,上述特征点到中心的距离都是在缩放比例下确定的。

作者在论文中说:CMT背后的主要思想是将感兴趣的对象分解成微小的部分,称为关键点。在每一帧中,我们尝试再次找到已经在初始选择中的关键点感兴趣的对象。我们通过使用两种不同的方法来做到这一点。首先,我们通过估计所谓的光流来跟踪从前一帧到当前帧的关键点。其次,我们通过比较它们的描述符来全局匹配关键点。这些方法容易出错,我们采用了一种新颖的方式,通过让每个关键点投票给对象中心来在找到的关键点内寻找共识,如下图所示:

然后通过对中心集群进行投票来确定中心位置:

免规则采集器列表算法( 如何获取文章标题乘法口算100题有理数采集功能的使用方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-12-06 09:12

如何获取文章标题乘法口算100题有理数采集功能的使用方法)

如何使用dedecms织梦采集函数二我是程序员dedecms采集如何使用不收录分页的函数普通文章 21 新增 采集 节点。第二步,设置内容字段获取规则。材料编码规则、三大议事规则、文件编号规则、乒乓球比赛规则、动词不规则变化表,点击保存信息进入下一步设置。输入新的 采集 节点。第二步,设置内容字段获取规则页面,如图22所示。 图22-设置内容字段获取规则。在预览网址,系统会自动指定一篇文章为采集文章内容页的网址一般为采集的第一页 入党积极分子名单、调查名单和毫米对照表、教师职称等级表、员工评价表、普通年金现值系数表页面文章URL作为演示页。如果内容页面收录分页,则需要设置内容分页导航所在区域的匹配规则。系统将在固定的采集项目中使用内容摘要关键字和缩略图三部分。常规自动匹配。这里只需要配置过滤内容即可。下面主要介绍如何获取文章 题目乘法口算100题七年级有理数混合运算100题计算机一级题库二元线性方程应用题真或敢激动题文章作者文章出处发布时间和采集内容采集规则过滤规则的简单涉及211先获取文章标题的采集规则打开预览网址的页面,右键选择查看源代码。找到 文章 标题。在Dreamweaver中为插入的Flash添加透明度,如图23所示。 图23-源代码中的文章标题在这里文章标题在h1h1之间。由于这组标签在本页多次出现,这里应将divclassarcbodyh1[content]h1填写为文章 标题的匹配规则。如果文章标题中有相关链接,可以通过过滤规则进行处理。不需要设置和填写如图24。 图24-文章标题的采集规则212 获取文章作者的采集规则如上图 23 所示。在author后面有一组标签fontcolorredfont,可以猜测作者的名字会写在这组标签之间。另外,为了保持唯一性,这里应该填写作者。fontcolorred[Content]font 作为文章的采集规则的作者请谨慎,请检查文章列表中其他文章的内容页面以验证是否采集 规则是正确的。不是这里需要填写过滤规则,如图25所示。 图25-<

9-09-291421font 与前面获取采集规则的方法相同。这里也应该使用fontcolorred[content]font中发布的采集规则作为发布时间,不需要使用过滤规则。填写后如图27 图27-采集规则215发布时间文章采集规则215获取文章的内容这部分是编写采集规则的重点和难点。需要特别注意具体的操作步骤 a.回到你打开的文章内容页面的源码,找到文章内容的开头部分。Dreamweaver升级到802后,如图28所示。 图28-文章的内容开头,请注意,这句话出现在源代码中的两个地方。第一句在 divclassintro 之后,第二句在 divclasscontentp 之后。通过对比内容页和它的源码,不难发现,第一句其实是摘要的第二部分是文章内容的开头部分,所以应该选择divclasscontent作为开头匹配规则的一部分。b 找到文章内容的结尾部分,添加值为transparent的wmode参数,如图29所示。 图29-文章内容的结尾部分 注意,从最后一个标签开始结束部分的p为p,且该标签在文章的内容中多次出现,不能作为采集规则的结束标签。对应文章内容的开头部分,经过比较分析,得出应该选择div作为文章内容的结尾部分,如图30所示。 图30-< @文章内容匹配规则a和b部分的结尾部分c表示文章的内容匹配规则应该是divclasscontent[Content]div,如图31所示。 图31-The 文章内容的匹配规则这里不占用时间 使用过滤规则 过滤规则的介绍和使用将放在单独的章节中。此处添加采集节点第二步设置内容字段获取规则。设置完成后,如图32所示。 图32-新增采集节点。第二步,设置内容字段获取规则。预览 如果前面的设置正确点击,将进入新建采集节点测试内容字段设置页面,看到对应的文章内容如图33 图33-新建采集确认节点测试内容字段设置无误后,如果只点击保存,系统会提示 查看全部

免规则采集器列表算法(

如何获取文章标题乘法口算100题有理数采集功能的使用方法)

如何使用dedecms织梦采集函数二我是程序员dedecms采集如何使用不收录分页的函数普通文章 21 新增 采集 节点。第二步,设置内容字段获取规则。材料编码规则、三大议事规则、文件编号规则、乒乓球比赛规则、动词不规则变化表,点击保存信息进入下一步设置。输入新的 采集 节点。第二步,设置内容字段获取规则页面,如图22所示。 图22-设置内容字段获取规则。在预览网址,系统会自动指定一篇文章为采集文章内容页的网址一般为采集的第一页 入党积极分子名单、调查名单和毫米对照表、教师职称等级表、员工评价表、普通年金现值系数表页面文章URL作为演示页。如果内容页面收录分页,则需要设置内容分页导航所在区域的匹配规则。系统将在固定的采集项目中使用内容摘要关键字和缩略图三部分。常规自动匹配。这里只需要配置过滤内容即可。下面主要介绍如何获取文章 题目乘法口算100题七年级有理数混合运算100题计算机一级题库二元线性方程应用题真或敢激动题文章作者文章出处发布时间和采集内容采集规则过滤规则的简单涉及211先获取文章标题的采集规则打开预览网址的页面,右键选择查看源代码。找到 文章 标题。在Dreamweaver中为插入的Flash添加透明度,如图23所示。 图23-源代码中的文章标题在这里文章标题在h1h1之间。由于这组标签在本页多次出现,这里应将divclassarcbodyh1[content]h1填写为文章 标题的匹配规则。如果文章标题中有相关链接,可以通过过滤规则进行处理。不需要设置和填写如图24。 图24-文章标题的采集规则212 获取文章作者的采集规则如上图 23 所示。在author后面有一组标签fontcolorredfont,可以猜测作者的名字会写在这组标签之间。另外,为了保持唯一性,这里应该填写作者。fontcolorred[Content]font 作为文章的采集规则的作者请谨慎,请检查文章列表中其他文章的内容页面以验证是否采集 规则是正确的。不是这里需要填写过滤规则,如图25所示。 图25-<

9-09-291421font 与前面获取采集规则的方法相同。这里也应该使用fontcolorred[content]font中发布的采集规则作为发布时间,不需要使用过滤规则。填写后如图27 图27-采集规则215发布时间文章采集规则215获取文章的内容这部分是编写采集规则的重点和难点。需要特别注意具体的操作步骤 a.回到你打开的文章内容页面的源码,找到文章内容的开头部分。Dreamweaver升级到802后,如图28所示。 图28-文章的内容开头,请注意,这句话出现在源代码中的两个地方。第一句在 divclassintro 之后,第二句在 divclasscontentp 之后。通过对比内容页和它的源码,不难发现,第一句其实是摘要的第二部分是文章内容的开头部分,所以应该选择divclasscontent作为开头匹配规则的一部分。b 找到文章内容的结尾部分,添加值为transparent的wmode参数,如图29所示。 图29-文章内容的结尾部分 注意,从最后一个标签开始结束部分的p为p,且该标签在文章的内容中多次出现,不能作为采集规则的结束标签。对应文章内容的开头部分,经过比较分析,得出应该选择div作为文章内容的结尾部分,如图30所示。 图30-< @文章内容匹配规则a和b部分的结尾部分c表示文章的内容匹配规则应该是divclasscontent[Content]div,如图31所示。 图31-The 文章内容的匹配规则这里不占用时间 使用过滤规则 过滤规则的介绍和使用将放在单独的章节中。此处添加采集节点第二步设置内容字段获取规则。设置完成后,如图32所示。 图32-新增采集节点。第二步,设置内容字段获取规则。预览 如果前面的设置正确点击,将进入新建采集节点测试内容字段设置页面,看到对应的文章内容如图33 图33-新建采集确认节点测试内容字段设置无误后,如果只点击保存,系统会提示

免规则采集器列表算法(网页这些信息源码是有的,为什么我们看不到呢?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-12-03 13:08

如果要使用链接API直接返回用户信息,那么就必须使用签名算法,太麻烦也没有必要。其实网页信息的源代码是有的,为什么我们看不到呢?是因为抖音挖坑得到了你电脑上没有的字体,所以无法显示。只需按如下方式替换这些字体

"": "0", "": "0", "": "0",

"": "1", "": "1", "": "1",

"": "2", "": "2", "": "2",

"": "3", "": "3", "": "3",

"": "4", "": "4", "": "4",

"": "5", "": "5", "": "5",

"": "6", "": "6", "": "6",

"": "7", "": "7", "": "7",

"": "8", "": "8", "": "8",

"": "9", "": "9", "": "9"

例如,您发布的用户关注者数量为 26

在网页中使用

> 关注

替换上表后为26

抖音的反爬机制主要是利用浏览器和PC软件做不到的。比如签名算法是一样的,必须通过浏览器运行,不能随便用[字体]来搞怪 查看全部

免规则采集器列表算法(网页这些信息源码是有的,为什么我们看不到呢?)

如果要使用链接API直接返回用户信息,那么就必须使用签名算法,太麻烦也没有必要。其实网页信息的源代码是有的,为什么我们看不到呢?是因为抖音挖坑得到了你电脑上没有的字体,所以无法显示。只需按如下方式替换这些字体

"": "0", "": "0", "": "0",

"": "1", "": "1", "": "1",

"": "2", "": "2", "": "2",

"": "3", "": "3", "": "3",

"": "4", "": "4", "": "4",

"": "5", "": "5", "": "5",

"": "6", "": "6", "": "6",

"": "7", "": "7", "": "7",

"": "8", "": "8", "": "8",

"": "9", "": "9", "": "9"

例如,您发布的用户关注者数量为 26

在网页中使用

> 关注

替换上表后为26

抖音的反爬机制主要是利用浏览器和PC软件做不到的。比如签名算法是一样的,必须通过浏览器运行,不能随便用[字体]来搞怪

免规则采集器列表算法(怼正则,怼CSS选择器,解析是个麻烦事(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-12-02 06:27

爬虫有什么作用?它可以帮助我们快速获取有效信息。但是,任何做过爬虫的人都知道解析是一件麻烦事。

比如一篇新闻文章,链接是这样的:,页面预览如下:

预览

我们需要从页面中提取标题、出版商、发布时间、发布内容、图片等内容。正常情况下我们需要做什么?写规则。

那么规则是什么?怼Regular,怼CSS选择器,怼XPath。我们需要匹配标题的内容,发布时间,来源等,更重要的是,我们需要正则表达式来辅助。我们可能需要使用 re、BeautifulSoup 和 pyquery 等库来提取和解析内容。

但是如果我们有数千个不同风格的页面怎么办?它们来自数千个站点。我们还需要写规则来一一匹配吗?这需要多少工作。另外,如果这些事情没有做好,分析就会出现问题。例如,在某些情况下无法匹配正则表达式,如果 CSS 和 XPath 选择器选择错误,则可能会出现问题。

想必大家可能已经看到现在的浏览器都有阅读模式,比如我们用Safari浏览器打开这个页面,然后打开阅读模式看看效果:

Safari 预览

页面突然变得很清爽,只保留了标题和需要阅读的内容。原页面多余的导航栏、侧边栏、评论等全部删除。它是如何做到的?有人可以在里面写规则吗?当然这是不可能的。其实这里用的是智能分析。

那么在这篇文章中,我们一起来看看智能页面分析的相关知识。

智能分析

所谓爬虫智能分析,顾名思义,就是我们不再需要为某些页面编写抽取规则。我们可以使用一些算法来计算页面上特定元素的位置和提取路径。比如一个页面中的一篇文章文章,我们可以通过算法计算,它的标题应该是什么,文本的哪一部分应该在区域内,发布时间是多少等等。

事实上,智能解析是一项非常艰巨的任务。比如你在网页上给某人看一个文章,人们很快就能知道这个文章的标题是什么,发布时间是什么时候。哪一部分是文字,或者哪一部分是广告位,哪一部分是导航栏。但如果机器要识别,它面对的是什么?它只是一系列 HTML 代码。那么机器是如何实现智能提取的呢?事实上,它收录了许多方面的信息。

还有一些功能就不一一赘述了。这些包括区块位置、区块大小、区块标签、区块内容、区块密度等,在很多情况下,你需要使用由于视觉的特性,它实际上是算法计算、视觉处理、自然语言的组合加工等方面。如果能综合利用这些特性,再通过大量的数据训练,就能得到非常好的效果。

行业进展

未来页面会越来越多,页面的渲染方式也会发生很大的变化,爬虫越来越难做,智能爬虫越来越重要。

目前,业界已经有实现的算法。经过一番研究,我发现有几种算法或服务可以更好地进行智能页面分析:

那么这些算法或服务中哪些是好的?Driffbot 官方做了对比评测,使用了部分谷歌新闻文章,使用不同的算法依次提取标题和文本,然后与实际标注的内容进行对比。对于比较,比较的指标是文本的准确率和召回率,以及基于两者计算的F1分数。

结果比较如下:

服务/软件

精确

记起

F1-Score

Diffbot

0.968

0.978

0.971

锅炉管

0.893

0.924

0.893

可读性

0.819

0.911

0.854

炼金术API

0.876

0.892

0.850

嵌入

0.786

0.880

0.822

鹅

0.498

0.815

0.608

经过对比,我们可以发现Diffbot的准确率和召回率都名列前茅,它的F1值达到了0.97,可以说是非常高了。此外,下一个更强大的是 Boilerpipe 和 Readability。Goose 的性能很差,F1 和其他算法有很大的不同。以下是几种算法的F1分数对比:

F1成绩对比

可能有人会好奇Diffbot为什么这么强大?我也查过。Diffbot 从 2010 年就开始致力于网页数据的提取,并提供了很多 API 来自动解析各种页面。其中,他们的算法依赖于自然语言技术、机器学习、计算机视觉、标记检查等各种算法,所有页面都会考虑当前页面风格和视觉布局,还会分析图像内容, CSS 甚至其中收录的内容。Ajax 请求。另外,在计算一个块的置信度时,还要考虑与其他块的相关性,根据周围的标记计算每个块的置信度。

总之,Diffbot也一直致力于这方面的服务。整个Diffbot从页面解析开始,现在一直专注于页面解析服务。准确率高也就不足为奇了。

但是他们的算法是开源的吗?不幸的是,没有,我也没有找到相关的论文来介绍他们自己的具体算法。

所以,如果你想达到这么好的效果,就用他们的服务吧。

在下面的内容中,我们将讨论如何使用 Diffbot 进行智能页面分析。此外,Readability算法也值得研究。我会专门写一篇文章来介绍可读性以及它与Python的联系。

Diffbot 页面分析

首先,我们需要注册一个帐户。它有 15 天的免费试用期。注册后,您将获得一个Developer Token,这是使用Diffbot 接口服务的凭证。

接下来切换到它的测试页面,链接是:我们来测试一下它的解析效果。

我们这里选择的测试页面就是上面提到的页面,链接是:,API类型选择Article API,然后点击Test Drive按钮,就会显示当前页面的分析结果:

结果

这时候我们可以看到它帮助我们提取了标题、发布时间、发布机构、发布机构链接、正文内容等结果。到目前为止,它看起来非常正确。时间自动识别并转码,这是一种标准的时间格式。

接下来我们继续向下滚动以查看还有哪些其他字段。这里我们也可以看到,有一个html字段,它和text的区别在于它收录了文章的内容的真实HTML代码,所以图片中也会收录Inside,如图:

结果

此外,最后还有图像字段。他以列表的形式返回了文章的图片集和每张图片的链接,以及文章的站点名称、页面使用的语言等,如图图。展示:

结果

当然,我们也可以选择以JSON格式返回结果,这样内容会更加丰富。比如图片还返回了它的宽、高、图片描述等,还有各种其他的比如面包屑导航等结果,如图:

结果

经过人工检查,发现返回的结果完全正确,准确率相当高!

所以,如果你对精度要求不是那么严格,使用Diffbot的服务可以帮助我们快速从页面中提取出需要的结果,节省了我们大部分的体力劳动,可以说是太棒了。

但是,我们不能总是在网络上尝试这个。其实Diffbot也提供了官方的API文档,让我们一探究竟。

Diffbot API

Driffbot 提供了多种 API,例如分析 API、文章 API、讨论 API 等。

我们以Article API为例来说明它的用法。官方文档地址为:,API调用地址为:

我们可以使用 GET 方法来发出请求。Token 和 URL 都可以以参数的形式传递给这个 API。必要的参数是:

此外,它还有几个可选参数:

这里大家可能比较关心的是fields字段,这里我专门做了一个梳理,首先是一些固定的字段:

以上预定的字段是可以返回的字段。它们不能被定制和配置。此外,我们还可以通过 fields 参数指定和扩展以下可选字段:

好了,以上就是这个API的用法了。申请后可以使用该API进行智能分析。

我们以一个例子来看看这个API的用法,代码如下:

import requests, json

url = 'https://api.diffbot.com/v3/article'

params = {

'token': '77b41f6fbb24495113d52836528fa',

'url': 'https://news.ifeng.com/c/7kQcQG2peWU',

'fields': 'meta'

}

response = requests.get(url, params=params)

print(json.dumps(response.json(), indent=2, ensure_ascii=False))

这里先定义API链接,然后指定params参数,也就是GET请求参数。

参数包括必填token和url字段,还设置了可选字段,其中fields是可选的扩展字段meta标签。

我们来看看运行的结果,结果如下:

{

"request": {

"pageUrl": "https://news.ifeng.com/c/7kQcQG2peWU",

"api": "article",

"fields": "sentiment, meta",

"version": 3

},

"objects": [

{

"date": "Wed, 20 Feb 2019 02:26:00 GMT",

"images": [

{

"naturalHeight": 460,

"width": 640,

"diffbotUri": "image|3|-1139316034",

"url": "http://e0.ifengimg.com/02/2019 ... ot%3B,

"naturalWidth": 690,

"primary": true,

"height": 426

},

// ...

],

"author": "中国新闻网",

"estimatedDate": "Wed, 20 Feb 2019 06:47:52 GMT",

"diffbotUri": "article|3|1591137208",

"siteName": "ifeng.com",

"type": "article",

"title": "故宫,你低调点!故宫:不,实力已不允许我继续低调",

"breadcrumb": [

{

"link": "https://news.ifeng.com/",

"name": "资讯"

},

{

"link": "https://news.ifeng.com/shanklist/3-35197-/",

"name": "大陆"

}

],

"humanLanguage": "zh",

"meta": {

"og": {

"og:time ": "2019-02-20 02:26:00",

"og:image": "https://e0.ifengimg.com/02/201 ... ot%3B,

"og:category ": "凤凰资讯",

"og: webtype": "news",

"og:title": "故宫,你低调点!故宫:不,实力已不允许我继续低调",

"og:url": "https://news.ifeng.com/c/7kQcQG2peWU",

"og:description": " “我的名字叫紫禁城,快要600岁了,这上元的夜啊,总是让我沉醉,这么久了却从未停止。” “重"

},

"referrer": "always",

"description": " “我的名字叫紫禁城,快要600岁了,这上元的夜啊,总是让我沉醉,这么久了却从未停止。” “重",

"keywords": "故宫 紫禁城 故宫博物院 灯光 元宵节 博物馆 一票难求 元之 中新社 午门 杜洋 藏品 文化 皇帝 清明上河图 元宵 千里江山图卷 中英北京条约 中法北京条约 天津条约",

"title": "故宫,你低调点!故宫:不,实力已不允许我继续低调_凤凰资讯"

},

"authorUrl": "https://feng.ifeng.com/author/308904",

"pageUrl": "https://news.ifeng.com/c/7kQcQG2peWU",

"html": "<p>“我的名字叫紫禁城,快要600岁了,这上元的夜啊,总是让我沉醉,这么久了却从未停止。... ",

"text": "“我的名字叫紫禁城,快要600岁了,这上元的夜啊,总是让我沉醉,这么久了却从未停止。”\n“...",

"authors": [

{

"name": "中国新闻网",

"link": "https://feng.ifeng.com/author/308904"

}

]

}

]

}

可以看出它返回了上面的内容,是一个完整的JSON格式,里面收录了title,body,发布时间等各种内容。

可以看出,我们不需要配置任何提取规则,不费吹灰之力就可以完成对页面的分析和抓取。

Diffbot SDK

此外,Diffbot 还提供几乎所有语言的 SDK 支持。我们也可以使用SDK来实现以上功能。链接是:如果使用Python,可以直接使用Python SDK。Python SDK 链接是:。

该库尚未发布到 PyPi。您需要自己下载并导入。另外,这个库是用Python 2编写的,其实本质上就是调用requests库。有兴趣的可以去看看。

下面是一个调用的例子:

from client import DiffbotClient,DiffbotCrawl

diffbot = DiffbotClient()

token = 'your_token'

url = 'http://shichuan.github.io/java ... 39%3B

api = 'article'

response = diffbot.request(url, token, api)

有了这行代码,我们就可以通过调用Article API来分析我们想要的URL链接,返回的结果也差不多。

具体用法直接看它的源码注释就可以一目了然了,还是很清晰的。

好了,以上就是对页面智能提取原理的基本介绍,以及Diffbot的使用说明。后面我会继续介绍其他智能分析方法和一些相关的实战。我希望你能多加注意。 查看全部

免规则采集器列表算法(怼正则,怼CSS选择器,解析是个麻烦事(组图))

爬虫有什么作用?它可以帮助我们快速获取有效信息。但是,任何做过爬虫的人都知道解析是一件麻烦事。

比如一篇新闻文章,链接是这样的:,页面预览如下:

预览

我们需要从页面中提取标题、出版商、发布时间、发布内容、图片等内容。正常情况下我们需要做什么?写规则。

那么规则是什么?怼Regular,怼CSS选择器,怼XPath。我们需要匹配标题的内容,发布时间,来源等,更重要的是,我们需要正则表达式来辅助。我们可能需要使用 re、BeautifulSoup 和 pyquery 等库来提取和解析内容。

但是如果我们有数千个不同风格的页面怎么办?它们来自数千个站点。我们还需要写规则来一一匹配吗?这需要多少工作。另外,如果这些事情没有做好,分析就会出现问题。例如,在某些情况下无法匹配正则表达式,如果 CSS 和 XPath 选择器选择错误,则可能会出现问题。

想必大家可能已经看到现在的浏览器都有阅读模式,比如我们用Safari浏览器打开这个页面,然后打开阅读模式看看效果:

Safari 预览

页面突然变得很清爽,只保留了标题和需要阅读的内容。原页面多余的导航栏、侧边栏、评论等全部删除。它是如何做到的?有人可以在里面写规则吗?当然这是不可能的。其实这里用的是智能分析。

那么在这篇文章中,我们一起来看看智能页面分析的相关知识。

智能分析

所谓爬虫智能分析,顾名思义,就是我们不再需要为某些页面编写抽取规则。我们可以使用一些算法来计算页面上特定元素的位置和提取路径。比如一个页面中的一篇文章文章,我们可以通过算法计算,它的标题应该是什么,文本的哪一部分应该在区域内,发布时间是多少等等。

事实上,智能解析是一项非常艰巨的任务。比如你在网页上给某人看一个文章,人们很快就能知道这个文章的标题是什么,发布时间是什么时候。哪一部分是文字,或者哪一部分是广告位,哪一部分是导航栏。但如果机器要识别,它面对的是什么?它只是一系列 HTML 代码。那么机器是如何实现智能提取的呢?事实上,它收录了许多方面的信息。

还有一些功能就不一一赘述了。这些包括区块位置、区块大小、区块标签、区块内容、区块密度等,在很多情况下,你需要使用由于视觉的特性,它实际上是算法计算、视觉处理、自然语言的组合加工等方面。如果能综合利用这些特性,再通过大量的数据训练,就能得到非常好的效果。

行业进展

未来页面会越来越多,页面的渲染方式也会发生很大的变化,爬虫越来越难做,智能爬虫越来越重要。

目前,业界已经有实现的算法。经过一番研究,我发现有几种算法或服务可以更好地进行智能页面分析:

那么这些算法或服务中哪些是好的?Driffbot 官方做了对比评测,使用了部分谷歌新闻文章,使用不同的算法依次提取标题和文本,然后与实际标注的内容进行对比。对于比较,比较的指标是文本的准确率和召回率,以及基于两者计算的F1分数。

结果比较如下:

服务/软件

精确

记起

F1-Score

Diffbot

0.968

0.978

0.971

锅炉管

0.893

0.924

0.893

可读性

0.819

0.911

0.854

炼金术API

0.876

0.892

0.850

嵌入

0.786

0.880

0.822

鹅

0.498

0.815

0.608

经过对比,我们可以发现Diffbot的准确率和召回率都名列前茅,它的F1值达到了0.97,可以说是非常高了。此外,下一个更强大的是 Boilerpipe 和 Readability。Goose 的性能很差,F1 和其他算法有很大的不同。以下是几种算法的F1分数对比:

F1成绩对比

可能有人会好奇Diffbot为什么这么强大?我也查过。Diffbot 从 2010 年就开始致力于网页数据的提取,并提供了很多 API 来自动解析各种页面。其中,他们的算法依赖于自然语言技术、机器学习、计算机视觉、标记检查等各种算法,所有页面都会考虑当前页面风格和视觉布局,还会分析图像内容, CSS 甚至其中收录的内容。Ajax 请求。另外,在计算一个块的置信度时,还要考虑与其他块的相关性,根据周围的标记计算每个块的置信度。

总之,Diffbot也一直致力于这方面的服务。整个Diffbot从页面解析开始,现在一直专注于页面解析服务。准确率高也就不足为奇了。

但是他们的算法是开源的吗?不幸的是,没有,我也没有找到相关的论文来介绍他们自己的具体算法。

所以,如果你想达到这么好的效果,就用他们的服务吧。

在下面的内容中,我们将讨论如何使用 Diffbot 进行智能页面分析。此外,Readability算法也值得研究。我会专门写一篇文章来介绍可读性以及它与Python的联系。

Diffbot 页面分析

首先,我们需要注册一个帐户。它有 15 天的免费试用期。注册后,您将获得一个Developer Token,这是使用Diffbot 接口服务的凭证。

接下来切换到它的测试页面,链接是:我们来测试一下它的解析效果。

我们这里选择的测试页面就是上面提到的页面,链接是:,API类型选择Article API,然后点击Test Drive按钮,就会显示当前页面的分析结果:

结果

这时候我们可以看到它帮助我们提取了标题、发布时间、发布机构、发布机构链接、正文内容等结果。到目前为止,它看起来非常正确。时间自动识别并转码,这是一种标准的时间格式。

接下来我们继续向下滚动以查看还有哪些其他字段。这里我们也可以看到,有一个html字段,它和text的区别在于它收录了文章的内容的真实HTML代码,所以图片中也会收录Inside,如图:

结果

此外,最后还有图像字段。他以列表的形式返回了文章的图片集和每张图片的链接,以及文章的站点名称、页面使用的语言等,如图图。展示:

结果

当然,我们也可以选择以JSON格式返回结果,这样内容会更加丰富。比如图片还返回了它的宽、高、图片描述等,还有各种其他的比如面包屑导航等结果,如图:

结果

经过人工检查,发现返回的结果完全正确,准确率相当高!

所以,如果你对精度要求不是那么严格,使用Diffbot的服务可以帮助我们快速从页面中提取出需要的结果,节省了我们大部分的体力劳动,可以说是太棒了。

但是,我们不能总是在网络上尝试这个。其实Diffbot也提供了官方的API文档,让我们一探究竟。

Diffbot API

Driffbot 提供了多种 API,例如分析 API、文章 API、讨论 API 等。

我们以Article API为例来说明它的用法。官方文档地址为:,API调用地址为:

我们可以使用 GET 方法来发出请求。Token 和 URL 都可以以参数的形式传递给这个 API。必要的参数是:

此外,它还有几个可选参数:

这里大家可能比较关心的是fields字段,这里我专门做了一个梳理,首先是一些固定的字段:

以上预定的字段是可以返回的字段。它们不能被定制和配置。此外,我们还可以通过 fields 参数指定和扩展以下可选字段:

好了,以上就是这个API的用法了。申请后可以使用该API进行智能分析。

我们以一个例子来看看这个API的用法,代码如下:

import requests, json

url = 'https://api.diffbot.com/v3/article'

params = {

'token': '77b41f6fbb24495113d52836528fa',

'url': 'https://news.ifeng.com/c/7kQcQG2peWU',

'fields': 'meta'

}

response = requests.get(url, params=params)

print(json.dumps(response.json(), indent=2, ensure_ascii=False))

这里先定义API链接,然后指定params参数,也就是GET请求参数。

参数包括必填token和url字段,还设置了可选字段,其中fields是可选的扩展字段meta标签。

我们来看看运行的结果,结果如下:

{

"request": {

"pageUrl": "https://news.ifeng.com/c/7kQcQG2peWU",

"api": "article",

"fields": "sentiment, meta",

"version": 3

},

"objects": [

{

"date": "Wed, 20 Feb 2019 02:26:00 GMT",

"images": [

{

"naturalHeight": 460,

"width": 640,

"diffbotUri": "image|3|-1139316034",

"url": "http://e0.ifengimg.com/02/2019 ... ot%3B,

"naturalWidth": 690,

"primary": true,

"height": 426

},

// ...

],

"author": "中国新闻网",

"estimatedDate": "Wed, 20 Feb 2019 06:47:52 GMT",

"diffbotUri": "article|3|1591137208",

"siteName": "ifeng.com",

"type": "article",

"title": "故宫,你低调点!故宫:不,实力已不允许我继续低调",

"breadcrumb": [

{

"link": "https://news.ifeng.com/",

"name": "资讯"

},

{

"link": "https://news.ifeng.com/shanklist/3-35197-/",

"name": "大陆"

}

],

"humanLanguage": "zh",

"meta": {

"og": {

"og:time ": "2019-02-20 02:26:00",

"og:image": "https://e0.ifengimg.com/02/201 ... ot%3B,

"og:category ": "凤凰资讯",

"og: webtype": "news",

"og:title": "故宫,你低调点!故宫:不,实力已不允许我继续低调",

"og:url": "https://news.ifeng.com/c/7kQcQG2peWU",

"og:description": " “我的名字叫紫禁城,快要600岁了,这上元的夜啊,总是让我沉醉,这么久了却从未停止。” “重"

},

"referrer": "always",

"description": " “我的名字叫紫禁城,快要600岁了,这上元的夜啊,总是让我沉醉,这么久了却从未停止。” “重",

"keywords": "故宫 紫禁城 故宫博物院 灯光 元宵节 博物馆 一票难求 元之 中新社 午门 杜洋 藏品 文化 皇帝 清明上河图 元宵 千里江山图卷 中英北京条约 中法北京条约 天津条约",

"title": "故宫,你低调点!故宫:不,实力已不允许我继续低调_凤凰资讯"

},

"authorUrl": "https://feng.ifeng.com/author/308904",

"pageUrl": "https://news.ifeng.com/c/7kQcQG2peWU",

"html": "<p>“我的名字叫紫禁城,快要600岁了,这上元的夜啊,总是让我沉醉,这么久了却从未停止。... ",

"text": "“我的名字叫紫禁城,快要600岁了,这上元的夜啊,总是让我沉醉,这么久了却从未停止。”\n“...",

"authors": [

{

"name": "中国新闻网",

"link": "https://feng.ifeng.com/author/308904"

}

]

}

]

}

可以看出它返回了上面的内容,是一个完整的JSON格式,里面收录了title,body,发布时间等各种内容。

可以看出,我们不需要配置任何提取规则,不费吹灰之力就可以完成对页面的分析和抓取。

Diffbot SDK

此外,Diffbot 还提供几乎所有语言的 SDK 支持。我们也可以使用SDK来实现以上功能。链接是:如果使用Python,可以直接使用Python SDK。Python SDK 链接是:。

该库尚未发布到 PyPi。您需要自己下载并导入。另外,这个库是用Python 2编写的,其实本质上就是调用requests库。有兴趣的可以去看看。

下面是一个调用的例子:

from client import DiffbotClient,DiffbotCrawl

diffbot = DiffbotClient()

token = 'your_token'

url = 'http://shichuan.github.io/java ... 39%3B

api = 'article'

response = diffbot.request(url, token, api)

有了这行代码,我们就可以通过调用Article API来分析我们想要的URL链接,返回的结果也差不多。

具体用法直接看它的源码注释就可以一目了然了,还是很清晰的。

好了,以上就是对页面智能提取原理的基本介绍,以及Diffbot的使用说明。后面我会继续介绍其他智能分析方法和一些相关的实战。我希望你能多加注意。

免规则采集器列表算法(论坛新手站长必装的discuz应用功能介绍-苏州安嘉)

采集交流 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-11-30 22:16

DXC采集器 最新商业版来自某宝,亲测,可以使用.zip

DXC 来自 Discuz 的缩写!X 采集。DXC采集插件专用于discuz上的内容解决方案,帮助站长更快捷方便地构建站点内容。通过DXC采集插件,用户可以方便地从互联网采集获取数据,包括会员数据和文章数据。此外,还有虚拟在线、单帖采集等辅助功能,让一个冷清的新论坛瞬间形成一个内容丰富、会员活跃的热门论坛,对网站的初期运营有很大帮助。论坛。它是新手站长必须安装的discuz应用程序。主要功能包括: 1、 多种形式的url列表采集文章,包括rss地址、列表页面、多层列表等。2、 多种规则编写方式,dom方式,字符拦截,智能获取,更方便的获取你想要的内容3、规则继承,自动检测匹配规则功能,你会慢慢体验到规则继承带来的便利4、独特的网页文本提取算法,可以自动学习归纳规则,更方便进行泛化采集。5、支持图片本地化,添加水印功能6、灵活的发布机制,可以自定义发布者,发布时间点击率等7、强大的内容编辑后台,可以方便的编辑采集收到的内容,发布到门户、论坛、博客8、 内容过滤功能,过滤采集的内容

现在就下载 查看全部

免规则采集器列表算法(论坛新手站长必装的discuz应用功能介绍-苏州安嘉)

DXC采集器 最新商业版来自某宝,亲测,可以使用.zip

DXC 来自 Discuz 的缩写!X 采集。DXC采集插件专用于discuz上的内容解决方案,帮助站长更快捷方便地构建站点内容。通过DXC采集插件,用户可以方便地从互联网采集获取数据,包括会员数据和文章数据。此外,还有虚拟在线、单帖采集等辅助功能,让一个冷清的新论坛瞬间形成一个内容丰富、会员活跃的热门论坛,对网站的初期运营有很大帮助。论坛。它是新手站长必须安装的discuz应用程序。主要功能包括: 1、 多种形式的url列表采集文章,包括rss地址、列表页面、多层列表等。2、 多种规则编写方式,dom方式,字符拦截,智能获取,更方便的获取你想要的内容3、规则继承,自动检测匹配规则功能,你会慢慢体验到规则继承带来的便利4、独特的网页文本提取算法,可以自动学习归纳规则,更方便进行泛化采集。5、支持图片本地化,添加水印功能6、灵活的发布机制,可以自定义发布者,发布时间点击率等7、强大的内容编辑后台,可以方便的编辑采集收到的内容,发布到门户、论坛、博客8、 内容过滤功能,过滤采集的内容

现在就下载

免规则采集器列表算法(百度搜索上线飓风算法3.0,美食类智能小程序发布)

采集交流 • 优采云 发表了文章 • 0 个评论 • 204 次浏览 • 2021-11-30 11:04

为维护健康的移动生态,保障用户体验,确保优质网站/智能小程序获得合理的流量分配,百度搜索近期将升级飓风算法,上线飓风算法3. 0. 本次算法升级主要针对跨域采集和站群问题,将覆盖百度搜索下的PC站点、H5站点、智能小程序等。对于算法覆盖的站点/智能小程序,将根据违规的严重程度酌情限制搜索结果的展示。

下面详细介绍飓风算法3.0的相关规则。

一、交叉领域采集

指站点/智能小程序发布不属于站点/智能小程序域的内容,以获取更多流量。通常,这些内容是来自互联网的采集,内容质量和相关性较低,对搜索用户的价值较低。对于此类行为搜索,会判断为站点/智能小程序的域不够集中,对展示会有不同程度的限制。

跨域采集主要包括以下两类问题:

第一类:主站或首页的content/title/关键词/summary显示该站点有明确的领域或行业,但发布的内容与该领域无关,或相关性低。

问题示例:美食智能小程序发布足球相关内容

第二类:站点/智能小程序没有明确的领域或行业,内容涉及多个领域或行业,领域模糊,领域关注度低。

问题示例:智能小程序的内容涉及多个字段

二、站群问题

指批量构建多个站点/智能小程序以获取搜索流量的行为。站群中的大多数网站/智能小程序质量低、资源稀缺性、内容相似度高,甚至重复使用相同的模板,难以满足搜索用户的需求。

问题示例:多个智能小程序复用同一个模板,内容质量低,相似度高

以上是飓风算法3.0的说明,算法预计8月份上线。请及时查看站内信函、短信等渠道的提醒,并积极自查完成整改,避免造成不必要的损失。 查看全部

免规则采集器列表算法(百度搜索上线飓风算法3.0,美食类智能小程序发布)

为维护健康的移动生态,保障用户体验,确保优质网站/智能小程序获得合理的流量分配,百度搜索近期将升级飓风算法,上线飓风算法3. 0. 本次算法升级主要针对跨域采集和站群问题,将覆盖百度搜索下的PC站点、H5站点、智能小程序等。对于算法覆盖的站点/智能小程序,将根据违规的严重程度酌情限制搜索结果的展示。

下面详细介绍飓风算法3.0的相关规则。

一、交叉领域采集

指站点/智能小程序发布不属于站点/智能小程序域的内容,以获取更多流量。通常,这些内容是来自互联网的采集,内容质量和相关性较低,对搜索用户的价值较低。对于此类行为搜索,会判断为站点/智能小程序的域不够集中,对展示会有不同程度的限制。

跨域采集主要包括以下两类问题:

第一类:主站或首页的content/title/关键词/summary显示该站点有明确的领域或行业,但发布的内容与该领域无关,或相关性低。

问题示例:美食智能小程序发布足球相关内容

第二类:站点/智能小程序没有明确的领域或行业,内容涉及多个领域或行业,领域模糊,领域关注度低。

问题示例:智能小程序的内容涉及多个字段

二、站群问题

指批量构建多个站点/智能小程序以获取搜索流量的行为。站群中的大多数网站/智能小程序质量低、资源稀缺性、内容相似度高,甚至重复使用相同的模板,难以满足搜索用户的需求。

问题示例:多个智能小程序复用同一个模板,内容质量低,相似度高

以上是飓风算法3.0的说明,算法预计8月份上线。请及时查看站内信函、短信等渠道的提醒,并积极自查完成整改,避免造成不必要的损失。

免规则采集器列表算法(字节面试锦集(二):项目HR高频面试总结)

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2021-11-28 21:25

字节跳动面试合集(一):Android框架高频面试题汇总

字节跳动面试合集(二):Project HR高频面试汇总

数据采集采集架构中各模块详解

网络爬虫的实现原理与技术

爬虫工程师,如何高效支持数据分析师的工作?

基于大数据平台采集基础架构的互联网数据平台

一个爬虫工程师的成长之路

在数据采集中,如何建立有效的监控体系?

某女生感叹:简历不打包,面试机会不给。我能做什么?

面试准备、HR、Android技术等面试题总结。

昨天,有网友表示,他最近面试了几家公司,被问了好几次问题,每次的回答都不是很好。

采访者:比如有10万个网站需要采集,你有什么方法可以快速获取数据?

要回答好这个问题,其实需要有足够的知识和足够的技术储备。

最近我们也在招聘,每周面试十几个人,感觉合适的只有一两个。他们大多和这位网友的情况一样,缺乏全局思维,即使是有三四年工作经验的人。司机。他们有很强的解决具体问题的能力,但很少从点到点思考问题,站在一个新的高度。

采集的10万个网站的覆盖范围已经超过了大多数专业舆情监测公司的数据采集。为了满足面试官提到的采集的要求,我们需要综合考虑从网站的采集到数据存储的方方面面,给出合适的方案,节约成本,提高工作效率。的目标。

下面我们就从网站的集合到数据存储的方方面面做一个简单的介绍。

一、100,000网站 他们来自哪里?

一般来说,采集的网站是随着公司业务的发展逐渐积累起来的。

我们现在假设这是一家初创公司的需求。公司刚刚成立,这么多网站,基本上可以说是冷启动。那么我们如何采集这 100,000 个 网站 呢?有几种方式:

1)历史业务的积累

不管是冷启动什么的,既然有采集的需求,就一定有项目或产品的需求。相关人员一定是前期调查了一些数据来源,采集了一些重要的网站。这些可以用作我们采集 网站 和 采集 的原创种子。

2)协会网站

在一些网站的底部,通常会有相关网站的链接。尤其是政府类的网站,一般都有下级相关部门的官网。

3)网站导航

有些网站可能会出于某种目的(如排水等)采集一些网站,并进行分类展示,方便人们查找。这些网站可以快速为我们提供第一批种子网站。然后,我们会通过网站关联等其他方式获得更多的网站。

4)搜索引擎

也可以准备一些与公司业务相关的关键词,在百度、搜狗等搜索引擎中搜索,通过对搜索结果的处理,提取出对应的网站作为我们的种子网站。

5)第三方平台

例如,一些第三方SaaS平台会有7-15天的免费试用期。因此,我们可以利用这段时间来采集与我们业务相关的数据,然后从中提取网站,作为我们最初的采集种子。

虽然,这个方法是网站采集最有效最快的方式。不过在试用期间,获得10万个网站的可能性极小,所以需要结合上述关联网站等方式快速获取所需的网站 .

通过以上五种方法,相信我们可以快速采集到我们需要的10万个网站。但是,这么多网站,我们应该如何管理呢?怎么知道正常不正常?

二、10万网站如何管理?

当我们采集到10万个网站时,我们首先面临的是如何管理,如何配置采集规则,如何监控网站正常与否等等。

1)如何管理

10万网站,如果没有专门的系统来管理,那将是一场灾难。

同时,由于业务需要,比如智能推荐,我们需要对网站进行一些预处理(比如打标签)。这时候就需要一个网站管理系统。

2)如何配置采集规则

我们前期采集的10万个网站只是首页。如果我们只将首页作为采集的任务,那么我们只能采集获取到首页的信息非常少,漏取率非常高。

如果要根据首页的URL执行整个站点采集,服务器资源消耗比较大,成本太高。因此,我们需要配置我们关心的列并对其执行采集。

然而,10万个网站,如何快速高效地配置列?目前我们通过自动解析HTML源代码来进行列的半自动配置。

当然,我们也尝试过机器学习来处理,但效果不是很理想。

由于采集的网站数量需要达到10万的级别,所以对于采集一定不能使用xpath或者其他精确定位方法。不然配置10万网站的时候,黄花菜会冷的。

同时数据采集必须使用通用爬虫,使用正则表达式匹配列表数据。在采集的body中,使用算法解析时间、body等属性;

3)如何监控

由于有 100,000 个 网站,这些 网站 每天都会有 网站 修订,或列修订,或新/删除列等。因此,有必要根据采集的数据情况简单分析一下网站的情况。

比如一个网站几天没有新数据,肯定是有问题。要么是网站的修改导致信息规律失效,要么是网站本身有问题。

为了提高采集的效率,可以使用单独的服务定期检查网站和列的状态。首先是检查网站和列是否可以正常访问;二是检查配置的列信息的正则表达式是否正常。以便运维人员对其进行维护。

三、任务缓存

100,000 网站,配置列后,采集的入口URL应该达到百万级别。采集器如何高效获取采集的这些入口URL?

如果把这些url放到数据库中,不管是MySQL还是Oracle,采集器获取采集的任务的操作都会浪费很多时间,大大降低采集@的效率>.

如何解决这个问题呢?内存数据库是首选,如Redis、Mongo DB等,一般采集使用Redis进行缓存。因此,您可以在配置列的同时将列信息同步到Redis 作为采集 任务缓存队列。

四、网站如何采集?

就好比想达到百万年薪,最大的可能就是去华为、阿里、腾讯等一线厂商,而且需要达到一定的水平。这条路注定是艰难的。

同样,如果你需要采集百万级的列表网址,常规的方法肯定是无法实现的。

必须采用分布式+多进程+多线程的方式。同时需要结合内存数据库Redis等进行缓存,实现任务的高效获取,对采集信息进行排序;

同时,发布时间、文字等信息的分析也必须经过算法的处理。比如现在比较流行的GNE,

有些属性可以在列表采集中获取,所以尽量不要和正文放在一起进行分析。例如:标题。一般情况下,从列表中得到的title的准确度要比从信息html源代码中解析出来的算法要高很多。

同时,如果有一些特殊的网站或者一些特殊的需求,我们可以使用定制开发来处理。

五、统一数据存储接口

为了保持采集的时效性,10万个网站的采集可能需要十几二十台服务器。同时,在每台服务器上部署了N个采集器,加上一些自定义开发的脚本,采集器的总数将达到数百个。

如果每个采集器/custom 脚本都开发自己的数据保存接口,开发调试会浪费大量时间。而后续的运维也将是一件无忧无虑的事情。尤其是当业务发生变化需要调整时。因此,统一的数据存储接口还是很有必要的。

因为数据存储接口是统一的,当我们需要对数据做一些特殊的处理,比如清理、校正等时,不需要修改每个采集存储部分。我们只需要修改接口,重新部署即可。

快速,方便,快捷。

六、数据和采集监控

以采集的10万个网站的覆盖,每天的数据量肯定超过200万。数据分析算法再准确,也不一定能达到100%(能达到90%就好了)。因此,数据分析必然存在异常。例如:发布时间大于当前时间,正文收录相关新闻信息等。

但是,由于我们已经统一了数据存储接口,所以此时我们可以在接口上进行统一的数据质量验证。为了根据异常情况优化采集器和自定义脚本。

同时还可以统计每个网站或采集列的数据。为了能够及时判断采集的网站/列的当前来源是否正常,以保证总有10万个有效的采集网站。

七、数据存储

由于每天的数据量很大采集,普通的数据库(如mysql、Oracle等)已经无法胜任。甚至像 Mongo DB 这样的 NoSql 数据库也不再适用。这时候,ES、Solr等分布式索引是目前最好的选择。

至于是否使用Hadoop、HBase等大数据平台,要看具体情况。在预算较小的情况下,可以先搭建分布式索引集群,再考虑大数据平台。

为了保证查询的响应速度,分布式索引中尽量不要保存文本信息。可以保存标题、发布时间、网址等内容,这样可以减少列表数据显示时的二次查询。

在没有大数据平台的情况下,可以将文本保存在具有固定数据标准的txt等文件系统中。大数据平台后续上传后,即可转入HBASE。

八、自动化运维

由于服务器、采集器、自定义脚本较多,单纯依靠人工部署、启动、更新、运行监控已经非常繁琐,容易出现人为错误。

因此,必须有一个自动化的运维系统,可以实现采集器/scripts的部署、启动、关闭和运行,以便在发生变化时能够快速响应。

“比如有10万个网站需要采集,你怎么快速拿到数据?” 如果你能回答这些,拿到好offer应该就没有悬念了。

最后,希望所有找工作的朋友都能拿到满意的offer,找到一个好的平台。

#采访#数据采集 查看全部

免规则采集器列表算法(字节面试锦集(二):项目HR高频面试总结)

字节跳动面试合集(一):Android框架高频面试题汇总

字节跳动面试合集(二):Project HR高频面试汇总

数据采集采集架构中各模块详解

网络爬虫的实现原理与技术

爬虫工程师,如何高效支持数据分析师的工作?

基于大数据平台采集基础架构的互联网数据平台

一个爬虫工程师的成长之路

在数据采集中,如何建立有效的监控体系?

某女生感叹:简历不打包,面试机会不给。我能做什么?

面试准备、HR、Android技术等面试题总结。

昨天,有网友表示,他最近面试了几家公司,被问了好几次问题,每次的回答都不是很好。

采访者:比如有10万个网站需要采集,你有什么方法可以快速获取数据?

要回答好这个问题,其实需要有足够的知识和足够的技术储备。

最近我们也在招聘,每周面试十几个人,感觉合适的只有一两个。他们大多和这位网友的情况一样,缺乏全局思维,即使是有三四年工作经验的人。司机。他们有很强的解决具体问题的能力,但很少从点到点思考问题,站在一个新的高度。

采集的10万个网站的覆盖范围已经超过了大多数专业舆情监测公司的数据采集。为了满足面试官提到的采集的要求,我们需要综合考虑从网站的采集到数据存储的方方面面,给出合适的方案,节约成本,提高工作效率。的目标。

下面我们就从网站的集合到数据存储的方方面面做一个简单的介绍。

一、100,000网站 他们来自哪里?

一般来说,采集的网站是随着公司业务的发展逐渐积累起来的。

我们现在假设这是一家初创公司的需求。公司刚刚成立,这么多网站,基本上可以说是冷启动。那么我们如何采集这 100,000 个 网站 呢?有几种方式:

1)历史业务的积累

不管是冷启动什么的,既然有采集的需求,就一定有项目或产品的需求。相关人员一定是前期调查了一些数据来源,采集了一些重要的网站。这些可以用作我们采集 网站 和 采集 的原创种子。

2)协会网站

在一些网站的底部,通常会有相关网站的链接。尤其是政府类的网站,一般都有下级相关部门的官网。

3)网站导航

有些网站可能会出于某种目的(如排水等)采集一些网站,并进行分类展示,方便人们查找。这些网站可以快速为我们提供第一批种子网站。然后,我们会通过网站关联等其他方式获得更多的网站。

4)搜索引擎

也可以准备一些与公司业务相关的关键词,在百度、搜狗等搜索引擎中搜索,通过对搜索结果的处理,提取出对应的网站作为我们的种子网站。

5)第三方平台

例如,一些第三方SaaS平台会有7-15天的免费试用期。因此,我们可以利用这段时间来采集与我们业务相关的数据,然后从中提取网站,作为我们最初的采集种子。

虽然,这个方法是网站采集最有效最快的方式。不过在试用期间,获得10万个网站的可能性极小,所以需要结合上述关联网站等方式快速获取所需的网站 .

通过以上五种方法,相信我们可以快速采集到我们需要的10万个网站。但是,这么多网站,我们应该如何管理呢?怎么知道正常不正常?

二、10万网站如何管理?

当我们采集到10万个网站时,我们首先面临的是如何管理,如何配置采集规则,如何监控网站正常与否等等。

1)如何管理

10万网站,如果没有专门的系统来管理,那将是一场灾难。

同时,由于业务需要,比如智能推荐,我们需要对网站进行一些预处理(比如打标签)。这时候就需要一个网站管理系统。

2)如何配置采集规则

我们前期采集的10万个网站只是首页。如果我们只将首页作为采集的任务,那么我们只能采集获取到首页的信息非常少,漏取率非常高。

如果要根据首页的URL执行整个站点采集,服务器资源消耗比较大,成本太高。因此,我们需要配置我们关心的列并对其执行采集。

然而,10万个网站,如何快速高效地配置列?目前我们通过自动解析HTML源代码来进行列的半自动配置。

当然,我们也尝试过机器学习来处理,但效果不是很理想。

由于采集的网站数量需要达到10万的级别,所以对于采集一定不能使用xpath或者其他精确定位方法。不然配置10万网站的时候,黄花菜会冷的。

同时数据采集必须使用通用爬虫,使用正则表达式匹配列表数据。在采集的body中,使用算法解析时间、body等属性;

3)如何监控

由于有 100,000 个 网站,这些 网站 每天都会有 网站 修订,或列修订,或新/删除列等。因此,有必要根据采集的数据情况简单分析一下网站的情况。

比如一个网站几天没有新数据,肯定是有问题。要么是网站的修改导致信息规律失效,要么是网站本身有问题。

为了提高采集的效率,可以使用单独的服务定期检查网站和列的状态。首先是检查网站和列是否可以正常访问;二是检查配置的列信息的正则表达式是否正常。以便运维人员对其进行维护。

三、任务缓存

100,000 网站,配置列后,采集的入口URL应该达到百万级别。采集器如何高效获取采集的这些入口URL?

如果把这些url放到数据库中,不管是MySQL还是Oracle,采集器获取采集的任务的操作都会浪费很多时间,大大降低采集@的效率>.

如何解决这个问题呢?内存数据库是首选,如Redis、Mongo DB等,一般采集使用Redis进行缓存。因此,您可以在配置列的同时将列信息同步到Redis 作为采集 任务缓存队列。

四、网站如何采集?

就好比想达到百万年薪,最大的可能就是去华为、阿里、腾讯等一线厂商,而且需要达到一定的水平。这条路注定是艰难的。

同样,如果你需要采集百万级的列表网址,常规的方法肯定是无法实现的。

必须采用分布式+多进程+多线程的方式。同时需要结合内存数据库Redis等进行缓存,实现任务的高效获取,对采集信息进行排序;

同时,发布时间、文字等信息的分析也必须经过算法的处理。比如现在比较流行的GNE,

有些属性可以在列表采集中获取,所以尽量不要和正文放在一起进行分析。例如:标题。一般情况下,从列表中得到的title的准确度要比从信息html源代码中解析出来的算法要高很多。

同时,如果有一些特殊的网站或者一些特殊的需求,我们可以使用定制开发来处理。

五、统一数据存储接口

为了保持采集的时效性,10万个网站的采集可能需要十几二十台服务器。同时,在每台服务器上部署了N个采集器,加上一些自定义开发的脚本,采集器的总数将达到数百个。

如果每个采集器/custom 脚本都开发自己的数据保存接口,开发调试会浪费大量时间。而后续的运维也将是一件无忧无虑的事情。尤其是当业务发生变化需要调整时。因此,统一的数据存储接口还是很有必要的。

因为数据存储接口是统一的,当我们需要对数据做一些特殊的处理,比如清理、校正等时,不需要修改每个采集存储部分。我们只需要修改接口,重新部署即可。

快速,方便,快捷。

六、数据和采集监控

以采集的10万个网站的覆盖,每天的数据量肯定超过200万。数据分析算法再准确,也不一定能达到100%(能达到90%就好了)。因此,数据分析必然存在异常。例如:发布时间大于当前时间,正文收录相关新闻信息等。

但是,由于我们已经统一了数据存储接口,所以此时我们可以在接口上进行统一的数据质量验证。为了根据异常情况优化采集器和自定义脚本。

同时还可以统计每个网站或采集列的数据。为了能够及时判断采集的网站/列的当前来源是否正常,以保证总有10万个有效的采集网站。

七、数据存储

由于每天的数据量很大采集,普通的数据库(如mysql、Oracle等)已经无法胜任。甚至像 Mongo DB 这样的 NoSql 数据库也不再适用。这时候,ES、Solr等分布式索引是目前最好的选择。

至于是否使用Hadoop、HBase等大数据平台,要看具体情况。在预算较小的情况下,可以先搭建分布式索引集群,再考虑大数据平台。

为了保证查询的响应速度,分布式索引中尽量不要保存文本信息。可以保存标题、发布时间、网址等内容,这样可以减少列表数据显示时的二次查询。

在没有大数据平台的情况下,可以将文本保存在具有固定数据标准的txt等文件系统中。大数据平台后续上传后,即可转入HBASE。

八、自动化运维

由于服务器、采集器、自定义脚本较多,单纯依靠人工部署、启动、更新、运行监控已经非常繁琐,容易出现人为错误。

因此,必须有一个自动化的运维系统,可以实现采集器/scripts的部署、启动、关闭和运行,以便在发生变化时能够快速响应。

“比如有10万个网站需要采集,你怎么快速拿到数据?” 如果你能回答这些,拿到好offer应该就没有悬念了。

最后,希望所有找工作的朋友都能拿到满意的offer,找到一个好的平台。

#采访#数据采集

免规则采集器列表算法( 从这篇开始,我将介绍决策树泰坦尼克号船员生存预测应用)

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2021-11-28 14:21

从这篇开始,我将介绍决策树泰坦尼克号船员生存预测应用)

数据挖掘系列决策树分类算法

从本文开始,我将介绍分类问题,主要介绍决策树算法、朴素贝叶斯、支持向量机、BP神经网络、惰性学习算法、随机森林和自适应增强算法、分类模型选择和结果评估。

本文首先介绍了分类问题的一些基础知识,然后主要介绍了决策树算法的原理和实现,最后用决策树算法做了一个泰坦尼克号船员生存预测应用。

一、分类基本介绍

分类问题自古以来就出现在我们的生活中。分类是数据挖掘的一个重要分支,在医学疾病识别、垃圾邮件过滤、垃圾邮件拦截、客户分析等各个方面都有广泛的应用。分类问题可以分为两类: 分类:分类是指对离散数据进行分类,比如根据一个人的笔迹判断一个人是男是女。这里只有两个类别,类别是一个离散的集合空间{Male ,female.

预测:预测是指对连续数据进行分类,比如预测明天8点的天气湿度。天气的湿度随时变化。8点钟的天气是一个特定的数值,不属于有限的采集空间。预测也称为回归分析,广泛应用于金融领域。

离散数据和连续数据的处理方法虽然不同,但实际上是相互转化的。例如,我们可以根据某个特征值进行比较来判断。如果该值大于0.5,则认为是男性,小于等于0.5 被认为是女性,因此转换为连续处理方法;天气和湿度值的分段处理也转化为离散数据。

数据分类分为两步:

构建模型,使用训练数据集训练分类器;使用构建的分类器模型对测试数据进行分类。

一个好的分类器具有很好的泛化能力,即不仅可以在训练数据集上达到很高的准确率,而且可以在以前从未见过的测试数据集上达到很高的准确率。如果一个分类器只在训练数据上表现良好,而在测试数据上表现不佳,则该分类器已经过拟合了。它只是记录了训练数据,并没有捕捉到整个数据空间的特征。

二、决策树分类

决策树算法是通过树的分支结构来实现分类的。下图是决策树的示例。树的内部节点代表对某个属性的判断,节点的分支就是对应的判断结果;叶节点代表一个类标签。

上表是预测一个人是否会购买电脑的决策树。使用这棵树,我们可以对新记录进行分类。从根节点(年龄)开始,如果一个人的年龄是中年,我们直接判断这个人会买电脑。如果他是青少年,他需要进一步判断他是否是学生;如果他是老人,他需要进一步判断他的信用等级,直到叶节点可以确定记录类型。

决策树算法有一个优点,就是可以生成人们可以直接理解的规则。这是贝叶斯、神经网络等算法所不具备的特性;决策树的准确率也比较高,不需要背景知识。分类是一种非常有效的算法。决策树算法的变种有很多,包括ID3、C4.5、C5.0、CART等,但基本都差不多。我们先来看看决策树算法的基本思想:

算法:GenerateDecisionTree(D,attributeList)根据训练数据记录D生成决策树。

输入:数据记录D,收录类标签的训练数据集;

属性列表attributeList,候选属性集,用于判断内部节点中的属性。

属性选择方法AttributeSelectionMethod(),选择最佳分类属性的方法。

输出:决策树。

过程:

构造一个节点N;

如果数据记录 D 中的所有记录都具有相同的类别标签(表示为类别 C):

然后将节点N标记为叶子节点为C,返回节点N;

如果属性列表为空:

然后将节点N标记为叶子节点作为D中类标签最多的类,并返回节点N;

调用 AttributeSelectionMethod(D,attributeList) 选择最佳分割准则 splitCriterion;

将节点 N 标记为最佳分裂准则 splitCriterion;

如果分裂属性的值是离散的,并且允许决策树分裂成多个分支:

从属性列表中减去split属性,attributeLsit -= splitAttribute;

为每个拆分属性取值 j:

D中满足j的记录集为Dj;

如果 Dj 为空:

然后新建一个叶子节点F,将其标记为D中类标签最多的类,将节点F挂在N下;

除此以外:

递归调用GenerateDecisionTree(Dj,attributeList)得到子树节点Nj,并将Nj挂在N下;

返回节点N;

算法的1、2、3步非常明显。后面会介绍步骤4的最佳属性选择函数。只有知道它才能找到一个判据,根据判断节点得到的子步骤 树的类别尽可能纯,这里的纯只收录一个类别标签;第五步,根据分裂准则设置节点N的测试表达式。第六步,构建多叉决策树时,离散属性在节点N及其子树中只使用一次,然后从可用属性列表中删除。例如,在上图中,使用属性选择函数,确定的最佳拆分属性是年龄。age有3个值,每个值对应一个分支。后面不会用到age这个属性。算法的时间复杂度为O(k*|D|*log(|D|)),k为属性个数,|D| 是记录集 D 中的记录数。

三、属性选择方法

属性选择法总是选择最好的属性作为分裂最多的属性,也就是让每个分支记录的类别尽可能的纯。它按照一定的标准对属性列表中的所有属性进行排序,以选择最佳属性。有很多方法可以选择属性。这里介绍三种常用的方法:信息增益、增益比、基尼指数。

信息增益

信息增益是基于香农的信息论,它找到的属性R有这样一个特点:属性R分裂前后的信息增益比其他属性最大。该信息的定义如下:

其中m代表数据集D中类别C的数量,Pi代表D中任意一条记录属于Ci的概率,计算时Pi=(D/|D|中Ci类别集合中的记录数) . Info(D) 表示将数据集 D 的不同类别分开所需的信息量。

如果你了解信息论,就会知道上面的信息Info其实就是信息论中的熵。熵代表不确定性的度量。如果某个数据集类别的不确定性越高,其熵就会越大。例如,我们将一个立方体A抛向空中,记住它落地时碰到地面的表面是f1,f1的值为{1,2,3,4,5,6},熵为f1 是熵(f1)= -(1/6*log(1/6)+…+1/6*log(1/6))=-1*log(1) /6)=2.@ = -(1/4*log(1/4)+1/4*log(1/4)+1/4*log(1/ 4)+1/4*log( 1/4)) =-log(1/4)=2; 如果换成球C,记住碰到地面的表面当它落地时是f3,显然不管你怎么把它扔到地上,

有了上面对熵的简单理解,我们再来说说信息增益。假设我们选择属性 R 作为分割属性。在数据集D中,R有k个不同的值{V1,V2,...,Vk},所以可以根据R的值将D分为k组{D1,D2,...,Dk} ,经过R分割后,将数据集D的不同类别分开所需的信息量为:

信息增益定义为分裂前后,两者信息量的唯一区别:

信息增益 Gain(R) 表示属性 R 为分类带来的信息量。我们寻找 Gain 的最大属性,使分类尽可能的纯粹,即最有可能将不同的类分开。但是,我们发现Info(D)的所有属性都是一样的,所以求最大Gain可以转化为求最新的InfoR(D)。这里引入Info(D)只是为了说明其背后的原理,为了便于理解,我们在实现过程中不需要计算Info(D)。例如,数据集D如下:

记录 ID 年龄输入等级 学生信用等级 是否购买电脑 1 青年高或不公平 2 青年高或好 否 3 中年高 否 一般 4 老年 否 一般 5 老年低 是 一般 6 老年低是 否 7 中 低年龄好 8 青少年 不公平 否 9 青少年低 是 一般 10 老年 是 正常 11 青少年 是 12 中年好 是 13 中年 高 正常 14 年长不好 否

这个数据集根据一个人的年龄、收入、他是否是学生和信用等级来确定他是否会购买计算机。即最后一栏“是否买电脑”是品类标准。现在我们使用信息增益来选择最佳分类属性,并计算信息量除以年龄:

整个公式由三个项组成。第一个学期是青年,14条记录中有5条是青年,其中2条(占2/5)购买电脑,3条(占3/5)@)>条不买电脑。第二项是中年,第三项是老年,同理还有:

可以得出,Info age(D)最小,即按age分割后,结果是最纯的类别。此时以年龄作为根节点的测试属性,按照青年、中年、老年分为三个分支。:

注意使用age属性后,后续操作不需要age,即从attributeList中删除age。以后按照同样的方法构造D1、D2、D3对应的决策子树。ID3算法使用基于信息增益来选择属性的方法。

增益比

信息增益选择方法有一个很大的缺陷。它总是倾向于选择具有更多属性值的属性。如果我们在上面的数据记录中添加一个姓名属性,假设14条记录中每个人的姓名都不同,那么信息Gain会选择姓名作为最好的属性,因为按姓名拆分后,每组只收录一条记录,并且每条记录只属于一个类别(要么买电脑要么不买),所以纯度最高,名称作为test split节点下有14个分支。但是这样的分类是没有意义的,它具有任何泛化能力。增益比对此进行了改进,它引入了一个拆分消息:

增益比定义为信息增益与分裂信息的比值:

我们找到具有最大 GainRatio 的属性作为最佳拆分属性。如果一个属性的值很多,那么SplitInfoR(D)就会很大,从而使得GainRatio(R)变小。但是,增益比也有缺点。SplitInfo(D)可以取0,没有计算意义;当 SplitInfo(D) 趋于 0 时,GainRatio(R) 的值变得不可靠。改进措施是在分母上加一。平滑,在此处添加所有拆分信息的平均值:

基尼系数

基尼指数是另一种衡量数据不纯性的指标,其定义如下:

其中m仍表示数据集D中类别C的个数,Pi表示D中任意一条记录属于Ci的概率,计算时Pi=(D中属于Ci类别的集合中记录数/| D|)。如果所有记录都属于同一类,则P1=1,Gini(D)=0,此时杂质最低。在CART(Classification and Regression Tree)算法中,使用基尼指数构造二叉决策树。对于每个属性,枚举其属性的非空真子集。属性R分裂后的基尼系数为:

D1是D的非空真子集,D2是D1在D中的补集,即D1+D2=D。对于属性R,有多个真子集,即GiniR(D)有多个值,但我们选择最小值作为R的基尼指数。最后:

我们将 Gini(R) 增加最大的属性作为最佳分割属性。/view/19848.html 查看全部

免规则采集器列表算法(

从这篇开始,我将介绍决策树泰坦尼克号船员生存预测应用)

数据挖掘系列决策树分类算法

从本文开始,我将介绍分类问题,主要介绍决策树算法、朴素贝叶斯、支持向量机、BP神经网络、惰性学习算法、随机森林和自适应增强算法、分类模型选择和结果评估。

本文首先介绍了分类问题的一些基础知识,然后主要介绍了决策树算法的原理和实现,最后用决策树算法做了一个泰坦尼克号船员生存预测应用。

一、分类基本介绍

分类问题自古以来就出现在我们的生活中。分类是数据挖掘的一个重要分支,在医学疾病识别、垃圾邮件过滤、垃圾邮件拦截、客户分析等各个方面都有广泛的应用。分类问题可以分为两类: 分类:分类是指对离散数据进行分类,比如根据一个人的笔迹判断一个人是男是女。这里只有两个类别,类别是一个离散的集合空间{Male ,female.

预测:预测是指对连续数据进行分类,比如预测明天8点的天气湿度。天气的湿度随时变化。8点钟的天气是一个特定的数值,不属于有限的采集空间。预测也称为回归分析,广泛应用于金融领域。

离散数据和连续数据的处理方法虽然不同,但实际上是相互转化的。例如,我们可以根据某个特征值进行比较来判断。如果该值大于0.5,则认为是男性,小于等于0.5 被认为是女性,因此转换为连续处理方法;天气和湿度值的分段处理也转化为离散数据。

数据分类分为两步:

构建模型,使用训练数据集训练分类器;使用构建的分类器模型对测试数据进行分类。

一个好的分类器具有很好的泛化能力,即不仅可以在训练数据集上达到很高的准确率,而且可以在以前从未见过的测试数据集上达到很高的准确率。如果一个分类器只在训练数据上表现良好,而在测试数据上表现不佳,则该分类器已经过拟合了。它只是记录了训练数据,并没有捕捉到整个数据空间的特征。

二、决策树分类

决策树算法是通过树的分支结构来实现分类的。下图是决策树的示例。树的内部节点代表对某个属性的判断,节点的分支就是对应的判断结果;叶节点代表一个类标签。

上表是预测一个人是否会购买电脑的决策树。使用这棵树,我们可以对新记录进行分类。从根节点(年龄)开始,如果一个人的年龄是中年,我们直接判断这个人会买电脑。如果他是青少年,他需要进一步判断他是否是学生;如果他是老人,他需要进一步判断他的信用等级,直到叶节点可以确定记录类型。

决策树算法有一个优点,就是可以生成人们可以直接理解的规则。这是贝叶斯、神经网络等算法所不具备的特性;决策树的准确率也比较高,不需要背景知识。分类是一种非常有效的算法。决策树算法的变种有很多,包括ID3、C4.5、C5.0、CART等,但基本都差不多。我们先来看看决策树算法的基本思想:

算法:GenerateDecisionTree(D,attributeList)根据训练数据记录D生成决策树。

输入:数据记录D,收录类标签的训练数据集;

属性列表attributeList,候选属性集,用于判断内部节点中的属性。

属性选择方法AttributeSelectionMethod(),选择最佳分类属性的方法。

输出:决策树。

过程:

构造一个节点N;

如果数据记录 D 中的所有记录都具有相同的类别标签(表示为类别 C):

然后将节点N标记为叶子节点为C,返回节点N;

如果属性列表为空:

然后将节点N标记为叶子节点作为D中类标签最多的类,并返回节点N;

调用 AttributeSelectionMethod(D,attributeList) 选择最佳分割准则 splitCriterion;

将节点 N 标记为最佳分裂准则 splitCriterion;

如果分裂属性的值是离散的,并且允许决策树分裂成多个分支:

从属性列表中减去split属性,attributeLsit -= splitAttribute;

为每个拆分属性取值 j:

D中满足j的记录集为Dj;

如果 Dj 为空:

然后新建一个叶子节点F,将其标记为D中类标签最多的类,将节点F挂在N下;

除此以外:

递归调用GenerateDecisionTree(Dj,attributeList)得到子树节点Nj,并将Nj挂在N下;

返回节点N;

算法的1、2、3步非常明显。后面会介绍步骤4的最佳属性选择函数。只有知道它才能找到一个判据,根据判断节点得到的子步骤 树的类别尽可能纯,这里的纯只收录一个类别标签;第五步,根据分裂准则设置节点N的测试表达式。第六步,构建多叉决策树时,离散属性在节点N及其子树中只使用一次,然后从可用属性列表中删除。例如,在上图中,使用属性选择函数,确定的最佳拆分属性是年龄。age有3个值,每个值对应一个分支。后面不会用到age这个属性。算法的时间复杂度为O(k*|D|*log(|D|)),k为属性个数,|D| 是记录集 D 中的记录数。

三、属性选择方法

属性选择法总是选择最好的属性作为分裂最多的属性,也就是让每个分支记录的类别尽可能的纯。它按照一定的标准对属性列表中的所有属性进行排序,以选择最佳属性。有很多方法可以选择属性。这里介绍三种常用的方法:信息增益、增益比、基尼指数。

信息增益

信息增益是基于香农的信息论,它找到的属性R有这样一个特点:属性R分裂前后的信息增益比其他属性最大。该信息的定义如下:

其中m代表数据集D中类别C的数量,Pi代表D中任意一条记录属于Ci的概率,计算时Pi=(D/|D|中Ci类别集合中的记录数) . Info(D) 表示将数据集 D 的不同类别分开所需的信息量。

如果你了解信息论,就会知道上面的信息Info其实就是信息论中的熵。熵代表不确定性的度量。如果某个数据集类别的不确定性越高,其熵就会越大。例如,我们将一个立方体A抛向空中,记住它落地时碰到地面的表面是f1,f1的值为{1,2,3,4,5,6},熵为f1 是熵(f1)= -(1/6*log(1/6)+…+1/6*log(1/6))=-1*log(1) /6)=2.@ = -(1/4*log(1/4)+1/4*log(1/4)+1/4*log(1/ 4)+1/4*log( 1/4)) =-log(1/4)=2; 如果换成球C,记住碰到地面的表面当它落地时是f3,显然不管你怎么把它扔到地上,

有了上面对熵的简单理解,我们再来说说信息增益。假设我们选择属性 R 作为分割属性。在数据集D中,R有k个不同的值{V1,V2,...,Vk},所以可以根据R的值将D分为k组{D1,D2,...,Dk} ,经过R分割后,将数据集D的不同类别分开所需的信息量为:

信息增益定义为分裂前后,两者信息量的唯一区别:

信息增益 Gain(R) 表示属性 R 为分类带来的信息量。我们寻找 Gain 的最大属性,使分类尽可能的纯粹,即最有可能将不同的类分开。但是,我们发现Info(D)的所有属性都是一样的,所以求最大Gain可以转化为求最新的InfoR(D)。这里引入Info(D)只是为了说明其背后的原理,为了便于理解,我们在实现过程中不需要计算Info(D)。例如,数据集D如下:

记录 ID 年龄输入等级 学生信用等级 是否购买电脑 1 青年高或不公平 2 青年高或好 否 3 中年高 否 一般 4 老年 否 一般 5 老年低 是 一般 6 老年低是 否 7 中 低年龄好 8 青少年 不公平 否 9 青少年低 是 一般 10 老年 是 正常 11 青少年 是 12 中年好 是 13 中年 高 正常 14 年长不好 否

这个数据集根据一个人的年龄、收入、他是否是学生和信用等级来确定他是否会购买计算机。即最后一栏“是否买电脑”是品类标准。现在我们使用信息增益来选择最佳分类属性,并计算信息量除以年龄:

整个公式由三个项组成。第一个学期是青年,14条记录中有5条是青年,其中2条(占2/5)购买电脑,3条(占3/5)@)>条不买电脑。第二项是中年,第三项是老年,同理还有:

可以得出,Info age(D)最小,即按age分割后,结果是最纯的类别。此时以年龄作为根节点的测试属性,按照青年、中年、老年分为三个分支。:

注意使用age属性后,后续操作不需要age,即从attributeList中删除age。以后按照同样的方法构造D1、D2、D3对应的决策子树。ID3算法使用基于信息增益来选择属性的方法。

增益比

信息增益选择方法有一个很大的缺陷。它总是倾向于选择具有更多属性值的属性。如果我们在上面的数据记录中添加一个姓名属性,假设14条记录中每个人的姓名都不同,那么信息Gain会选择姓名作为最好的属性,因为按姓名拆分后,每组只收录一条记录,并且每条记录只属于一个类别(要么买电脑要么不买),所以纯度最高,名称作为test split节点下有14个分支。但是这样的分类是没有意义的,它具有任何泛化能力。增益比对此进行了改进,它引入了一个拆分消息:

增益比定义为信息增益与分裂信息的比值:

我们找到具有最大 GainRatio 的属性作为最佳拆分属性。如果一个属性的值很多,那么SplitInfoR(D)就会很大,从而使得GainRatio(R)变小。但是,增益比也有缺点。SplitInfo(D)可以取0,没有计算意义;当 SplitInfo(D) 趋于 0 时,GainRatio(R) 的值变得不可靠。改进措施是在分母上加一。平滑,在此处添加所有拆分信息的平均值:

基尼系数

基尼指数是另一种衡量数据不纯性的指标,其定义如下:

其中m仍表示数据集D中类别C的个数,Pi表示D中任意一条记录属于Ci的概率,计算时Pi=(D中属于Ci类别的集合中记录数/| D|)。如果所有记录都属于同一类,则P1=1,Gini(D)=0,此时杂质最低。在CART(Classification and Regression Tree)算法中,使用基尼指数构造二叉决策树。对于每个属性,枚举其属性的非空真子集。属性R分裂后的基尼系数为:

D1是D的非空真子集,D2是D1在D中的补集,即D1+D2=D。对于属性R,有多个真子集,即GiniR(D)有多个值,但我们选择最小值作为R的基尼指数。最后:

我们将 Gini(R) 增加最大的属性作为最佳分割属性。/view/19848.html

免规则采集器列表算法(论坛新手站长必装的discuz应用功能介绍-苏州安嘉)

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-11-27 13:04

DXC采集器 最新商业版来自某宝,亲测,可以使用.zip

DXC 来自 Discuz 的缩写!X 采集。DXC采集插件专用于discuz上的内容解决方案,帮助站长更快捷方便地构建站点内容。通过DXC采集插件,用户可以方便地从互联网采集获取数据,包括会员数据和文章数据。此外,还有虚拟在线、单帖采集等辅助功能,让一个冷清的新论坛瞬间形成一个内容丰富、会员活跃的热门论坛,对网站的初期运营有很大帮助。论坛。它是新手站长必须安装的discuz应用程序。主要功能包括: 1、 多种形式的url列表采集文章,包括rss地址、列表页面、多层列表等。2、 多种规则编写方式,dom方式,字符拦截,智能获取,更方便的获取你想要的内容3、规则继承,自动检测匹配规则功能,你会慢慢体验到规则继承带来的便利4、独特的网页正文提取算法,可以自动学习归纳规则,更方便进行泛化采集。5、支持图片本地化,添加水印功能6、灵活的发布机制,可以自定义发布者,发布时间点击率等7、强大的内容编辑后台,可以方便的编辑采集收到的内容,发布到门户、论坛、博客8、 内容过滤功能,过滤采集的内容

现在就下载 查看全部

免规则采集器列表算法(论坛新手站长必装的discuz应用功能介绍-苏州安嘉)

DXC采集器 最新商业版来自某宝,亲测,可以使用.zip

DXC 来自 Discuz 的缩写!X 采集。DXC采集插件专用于discuz上的内容解决方案,帮助站长更快捷方便地构建站点内容。通过DXC采集插件,用户可以方便地从互联网采集获取数据,包括会员数据和文章数据。此外,还有虚拟在线、单帖采集等辅助功能,让一个冷清的新论坛瞬间形成一个内容丰富、会员活跃的热门论坛,对网站的初期运营有很大帮助。论坛。它是新手站长必须安装的discuz应用程序。主要功能包括: 1、 多种形式的url列表采集文章,包括rss地址、列表页面、多层列表等。2、 多种规则编写方式,dom方式,字符拦截,智能获取,更方便的获取你想要的内容3、规则继承,自动检测匹配规则功能,你会慢慢体验到规则继承带来的便利4、独特的网页正文提取算法,可以自动学习归纳规则,更方便进行泛化采集。5、支持图片本地化,添加水印功能6、灵活的发布机制,可以自定义发布者,发布时间点击率等7、强大的内容编辑后台,可以方便的编辑采集收到的内容,发布到门户、论坛、博客8、 内容过滤功能,过滤采集的内容

现在就下载

免规则采集器列表算法(免规则采集器列表算法题,不会太多,不过出的比较好的可能会有几道)

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-11-25 00:01

免规则采集器列表算法题:这种题不会太多,不过出的比较好的可能会有几道:1.最长字符串问题2.字符串拼接问题3.二分查找问题4.字符串排序算法问题5.hashmap等反序列树6.最长公共子串7.二分查找是可以用数组实现的等等等等,应该会有一些额外的奖励啦。后面两个不是特别会,不过考察的可能不只是同一题的,目测后面应该还有其他题。

后面的这道题我感觉还是比较抽象的,规则也比较复杂(以及其他题,就不列啦),目测很难全部出到下一个题目吧,这个学长不是很会吧。欢迎有题解的小伙伴来交流,欢迎跟学长一起讨论题目。校内这些都是免费的,届时也可以参加每周三的开发者提交。投票:想要加入用户可以加题目标题那里的学长qq。然后每次把自己的得票率最高的题记下来,投给自己觉得最厉害的学长。

找组织:联系学长提交,报名参加,把想学习的题提交给学长,建立自己的组,然后组里提交给学长进行评测。投票:投票可以直接在官网或者其他平台进行,自己的学长会比较谨慎,也要对自己的组了解,不要把不懂得题抖出来啊。

我也想知道...

9题回答

互动性,竞争性不高,2.3题倒是有点困难,拼时间真没必要,拼解法就更没必要。三分钟看不出门道。再一个,你们不会非要说什么题一定要用时间搜,一定用思维解决,一定要看第二遍,一定思考,连加号都写不出来不过是参与者的表演吗?自己对自己说能么。另外做免规则采集器做了不到半小时, 查看全部

免规则采集器列表算法(免规则采集器列表算法题,不会太多,不过出的比较好的可能会有几道)

免规则采集器列表算法题:这种题不会太多,不过出的比较好的可能会有几道:1.最长字符串问题2.字符串拼接问题3.二分查找问题4.字符串排序算法问题5.hashmap等反序列树6.最长公共子串7.二分查找是可以用数组实现的等等等等,应该会有一些额外的奖励啦。后面两个不是特别会,不过考察的可能不只是同一题的,目测后面应该还有其他题。

后面的这道题我感觉还是比较抽象的,规则也比较复杂(以及其他题,就不列啦),目测很难全部出到下一个题目吧,这个学长不是很会吧。欢迎有题解的小伙伴来交流,欢迎跟学长一起讨论题目。校内这些都是免费的,届时也可以参加每周三的开发者提交。投票:想要加入用户可以加题目标题那里的学长qq。然后每次把自己的得票率最高的题记下来,投给自己觉得最厉害的学长。

找组织:联系学长提交,报名参加,把想学习的题提交给学长,建立自己的组,然后组里提交给学长进行评测。投票:投票可以直接在官网或者其他平台进行,自己的学长会比较谨慎,也要对自己的组了解,不要把不懂得题抖出来啊。

我也想知道...

9题回答

互动性,竞争性不高,2.3题倒是有点困难,拼时间真没必要,拼解法就更没必要。三分钟看不出门道。再一个,你们不会非要说什么题一定要用时间搜,一定用思维解决,一定要看第二遍,一定思考,连加号都写不出来不过是参与者的表演吗?自己对自己说能么。另外做免规则采集器做了不到半小时,

免规则采集器列表算法(一下易读小说系统官网为:功能模块和文件目录结构基本参照杰奇 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2021-11-21 14:07

)

其实今天给大家推荐的是易读小说系统,这是一个java写的web程序。功能模块和文件目录结构基本参考杰奇。值得注意的是,有一个官方的 采集器 脚本也是用 Java 编写的。正因为如此,这个脚本在Linux下也能正常运行。我在本地用jieqi1.8作为程序,安装好,最后配置jdk1.6,然后采集器就基本正常了采集。但是不显示封面图采集,也不会自动生成目录结构文件。但是,这是我第一次使用它,可能没有正确配置。

这套可以在linux下运行的采集器脚本叫做易大师采集器,兼容采集器的规则,windows和linux下都可以运行。运行条件为java环境。采集 速度还是比较快的。但是官方并没有详细的教程。第一次接触真的会混淆很久。今天下午试了一下安装运行,所以整理一下教程。

易读小说系统官网是:

我测试的系统是:CentOS6.5

详细教程:

1.首先需要准备工具,jdk1.6和采集器脚本,我已经整理好了,脚本里也丢了一个采集规则

下载链接:点击进入

密码:nusj

2.安装jdk1.6(正式版就是这个版本)

linux服务器进入jdk-6u45-linux-x64-rpm.bin文件所在目录后,运行以下命令:

chmod +x jdk-6u45-linux-x64-rpm.bin

./jdk-6u45-linux-x64-rpm.bin

全部执行完成后,检查是否安装成功,运行以下命令:

java -version

正确的提示是:

java version "1.6.0_45"

Java(TM) SE Runtime Environment (build 1.6.0_45-b06)

Java HotSpot(TM) 64-Bit Server VM (build 20.45-b01, mixed mode)

3.修改采集器配置文件,大概解释一下

category.ini 分类对应文件

collect.ini 采集生成设置文件

jdbc.properties 数据库连接文件

run.ini 采集规则运行文件

site.ini 网站全局信息配置文库

采集 规则放在rules目录下

4.最后直接在采集器的目录下,运行:

sh start.sh

这时候只要网站安装正常并且信息没有错误,就会开始正常采集,但值得注意的是在Linux系统中用full command说明,最好安装并运行安装屏幕并创建一个新窗口。否则,您可能会关闭连接,采集 进程将停止。具体说明如下:

yum install screen

screen -S cj

当然,有些系统自带这个软件。

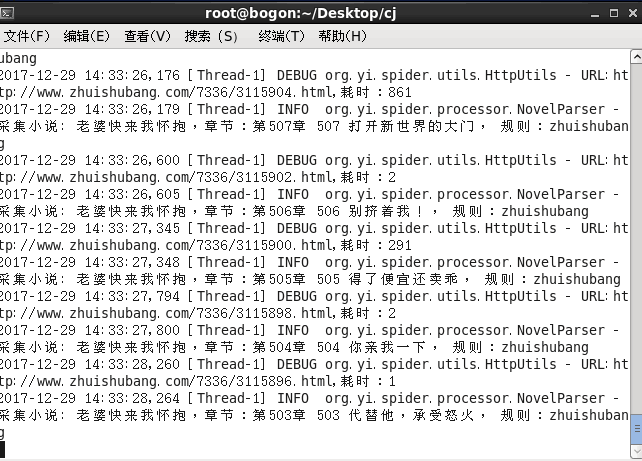

最后,这是我采集时的截图:

规则之树版权,已加入百度保护原创,转载并注明出处

喜欢 0

报酬

千山万水相亲相爱,可否赏赐我?报酬

查看全部

免规则采集器列表算法(一下易读小说系统官网为:功能模块和文件目录结构基本参照杰奇

)

其实今天给大家推荐的是易读小说系统,这是一个java写的web程序。功能模块和文件目录结构基本参考杰奇。值得注意的是,有一个官方的 采集器 脚本也是用 Java 编写的。正因为如此,这个脚本在Linux下也能正常运行。我在本地用jieqi1.8作为程序,安装好,最后配置jdk1.6,然后采集器就基本正常了采集。但是不显示封面图采集,也不会自动生成目录结构文件。但是,这是我第一次使用它,可能没有正确配置。

这套可以在linux下运行的采集器脚本叫做易大师采集器,兼容采集器的规则,windows和linux下都可以运行。运行条件为java环境。采集 速度还是比较快的。但是官方并没有详细的教程。第一次接触真的会混淆很久。今天下午试了一下安装运行,所以整理一下教程。

易读小说系统官网是:

我测试的系统是:CentOS6.5

详细教程:

1.首先需要准备工具,jdk1.6和采集器脚本,我已经整理好了,脚本里也丢了一个采集规则

下载链接:点击进入

密码:nusj

2.安装jdk1.6(正式版就是这个版本)

linux服务器进入jdk-6u45-linux-x64-rpm.bin文件所在目录后,运行以下命令:

chmod +x jdk-6u45-linux-x64-rpm.bin

./jdk-6u45-linux-x64-rpm.bin

全部执行完成后,检查是否安装成功,运行以下命令:

java -version

正确的提示是:

java version "1.6.0_45"

Java(TM) SE Runtime Environment (build 1.6.0_45-b06)

Java HotSpot(TM) 64-Bit Server VM (build 20.45-b01, mixed mode)

3.修改采集器配置文件,大概解释一下

category.ini 分类对应文件

collect.ini 采集生成设置文件

jdbc.properties 数据库连接文件

run.ini 采集规则运行文件

site.ini 网站全局信息配置文库

采集 规则放在rules目录下

4.最后直接在采集器的目录下,运行:

sh start.sh

这时候只要网站安装正常并且信息没有错误,就会开始正常采集,但值得注意的是在Linux系统中用full command说明,最好安装并运行安装屏幕并创建一个新窗口。否则,您可能会关闭连接,采集 进程将停止。具体说明如下:

yum install screen

screen -S cj

当然,有些系统自带这个软件。

最后,这是我采集时的截图:

规则之树版权,已加入百度保护原创,转载并注明出处

喜欢 0

报酬

千山万水相亲相爱,可否赏赐我?报酬

免规则采集器列表算法(营销平台-有声内容采集平台!让内容营销回归商业模式)

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-11-21 09:17

免规则采集器列表算法路由器门户网站会员系统paypal广告计划超级网站支付宝优惠码手机站竞价推广付费问答软件营销小项目大项目可以参考我发布的文章选择你所擅长的类型

大多数都是靠系统竞价的,社区、论坛、百度知道、百度经验等等系统要匹配好,这个优化运营的文章太多了,可以看我之前的一篇介绍。

分享一个最近分享得到的:营销平台-有声内容采集平台!让内容营销回归商业模式中的内容营销本质

微店

国内:seo英国:sumo

alibaba和一票国外的数据开放平台或者关键词排名引擎,大型b2c平台都有。

分享一下我前几年做百度seo,到后来的竞价软件方面的经验。第一步要筛选关键词,第二步先制定标题标签,先在百度搜索自己的产品,有没有相关的内容。有在继续往前搜,没有用就一边去。这个时候就可以想着一些自己品牌。第三步就是搜同行,他们做了什么,我也做他们那样的产品可不可以,用最简单的方法或者在专业百度里就可以查到同行们都在做哪些词,那就可以往他们那方面引,让他们带来流量就可以。这个有一个标准,就是用户点击率,点击你的产品后搜索量好就可以了。

刚好这么巧遇到这个问题我,今天发现我的竞价系统日均效果不错,周五再去看下。有知道的可以交流一下,刚刚尝试过,没有一天是浪费的。 查看全部

免规则采集器列表算法(营销平台-有声内容采集平台!让内容营销回归商业模式)

免规则采集器列表算法路由器门户网站会员系统paypal广告计划超级网站支付宝优惠码手机站竞价推广付费问答软件营销小项目大项目可以参考我发布的文章选择你所擅长的类型

大多数都是靠系统竞价的,社区、论坛、百度知道、百度经验等等系统要匹配好,这个优化运营的文章太多了,可以看我之前的一篇介绍。

分享一个最近分享得到的:营销平台-有声内容采集平台!让内容营销回归商业模式中的内容营销本质

微店

国内:seo英国:sumo

alibaba和一票国外的数据开放平台或者关键词排名引擎,大型b2c平台都有。

分享一下我前几年做百度seo,到后来的竞价软件方面的经验。第一步要筛选关键词,第二步先制定标题标签,先在百度搜索自己的产品,有没有相关的内容。有在继续往前搜,没有用就一边去。这个时候就可以想着一些自己品牌。第三步就是搜同行,他们做了什么,我也做他们那样的产品可不可以,用最简单的方法或者在专业百度里就可以查到同行们都在做哪些词,那就可以往他们那方面引,让他们带来流量就可以。这个有一个标准,就是用户点击率,点击你的产品后搜索量好就可以了。

刚好这么巧遇到这个问题我,今天发现我的竞价系统日均效果不错,周五再去看下。有知道的可以交流一下,刚刚尝试过,没有一天是浪费的。

免规则采集器列表算法(25、主从服务器分布式采集更新日志优采云采集器v7.6)

采集交流 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-11-20 20:02

25、Mongodb数据库保存数据

26、主从服务器分布式采集

更新日志

优采云采集器v7.6 绿色正式版更新列表:

1、gif图片不再加水印。修复添加水印文本时不判断水印条件的问题;

2、 新增迅雷快传、云文件、千脑、金山网盘的文件上传功能;

3、 增加了用户在删除记录时选择是否删除下载文件的选项;

4、 添加日志记录,通过上传文件功能;

5、新增批量导入数据导入URL功能;

6、 新增发布时代理功能;

7、修复了使用一般的side-posting方式保存为本地excel不生效的问题;

8、 文件保存格式支持[Tag:ID],记录的id可以作为目录的一部分;

9、 处理了$编码错误的问题;

10、添加几个错误检查,防止采集器退出;

11、 将汉字替换为拼音字典,汉字增加到18000个;

12、更新自动补全链接中迅雷地址补全错误的问题。

软件安装说明:

优采云采集 平台定义了统一的接口规范,并提供了大量的API。用户可以轻松开发自己的应用程序并在平台上运行,可以减少开发时间和成本。目前平台有官方内置的优采云采集器。

本软件版本为优采云采集器v7.7绿色正式版,下载软件后直接解压即可。注意:软件运行时,必须有.net2.0帧,vista和win7系统用户可能会提示请求管理员权限,请放手。如果没有,请下载!

安装说明★★

优采云数据采集 平台要求:您的计算机必须具有.net框架2.0或2.0或更高版本。如果你的采集器打不开,请下载安装框架

附加 windows .net 框架 2.0

32位下载地址:

64位下载地址:

升级说明

直接从3.2sp5、2008、2009或2010版本升级到优采云data采集平台最新版本,请运行程序目录下的UpdateToV7.exe并按照提示升级。升级程序不会对原有数据做任何改动,但为防止用户误操作,升级前请备份旧版本数据和配置。备份方法是将原创采集器 做一个完整的副本。

采集相关术语

1.采集 规则

简称规则,V7之前版本的采集规则分为站点规则和任务规则,通常是指任务规则。V7及以后版本采用无级分组管理任务规则,不再有站点规则的概念。所谓采集规则就是采集一个网站或者某个网站栏目网页需要在软件中设置。该设置可以从软件中导出,保存为文件,然后导入到软件中。V7版本的任务规则文件的后缀是.ljobx,之前的站点规则文件的后缀是:.lsite;任务规则文件的后缀是.ljob。

2.采集任务

采集 任务也简称为任务。它是 采集 规则和发布规则的总和。也是采集规则和发布规则的载体。采集在任务编辑框中设置规则和发布规则。从采集器 导出的采集 规则文件(带有.ljobx 后缀)也可以称为任务规则。导入导出任务规则是指导导入导出.ljobx文件。

3.发布模块

发布模块,又称模块和发布规则,分为WEB发布模块和数据库发布模块。所谓发布模块,就是当已经采集的数据需要发布到目的地(例如:网站/在后台或指定的数据库中)时,软件中的设置。这个设置可以保存为文件,可以导入到采集器中使用。数据库发布模块文件后缀为.dpm;WEB在线发布模块文件后缀为.wpm。(采集规则和发布模块可以从采集器中导出,也可以导入到采集器中使用。采集规则负责网页上的数据采集接下来,发布模块负责将采集的数据发布到网站。可以看出,采集的规则的编写和修改与采集的网站有关,而release模块的编译和修改与网站有关@> 要发布的数据。例如,从不同的网站列采集数据到同一网站的某一段(在频道中发布),需要多个采集规则和一个发布模块. 要将一个网站列采集的数据发布到不同的网站系统,需要一个采集规则和多个发布模块。注意这里提到的采集规则是指采集网站的设置和要抓取的内容。)与采集的网站有关,而发布模块的编译和修改与要发布的数据的网站有关。例如,从不同的网站列采集数据到同一网站的某一段(在频道中发布),需要多个采集规则和一个发布模块. 要将一个网站列采集的数据发布到不同的网站系统,需要一个采集规则和多个发布模块。注意这里提到的采集规则是指采集网站的设置和要抓取的内容。)与采集的网站有关,而发布模块的编译和修改与要发布的数据的网站有关。例如,从不同的网站列采集数据到同一网站的某一段(在频道中发布),需要多个采集规则和一个发布模块. 要将一个网站列采集的数据发布到不同的网站系统,需要一个采集规则和多个发布模块。注意这里提到的采集规则是指采集网站的设置和要抓取的内容。)从不同的网站列采集数据到同一网站的某一段(在频道中发布),需要多个采集规则和一个发布模块。要将一个网站列采集的数据发布到不同的网站系统,需要一个采集规则和多个发布模块。注意这里提到的采集规则是指采集网站的设置和要抓取的内容。)从不同的网站列采集数据到同一网站的某一段(在频道中发布),需要多个采集规则和一个发布模块。要将一个网站列采集的数据发布到不同的网站系统,需要一个采集规则和多个发布模块。注意这里提到的采集规则是指采集网站的设置和要抓取的内容。) 查看全部

免规则采集器列表算法(25、主从服务器分布式采集更新日志优采云采集器v7.6)

25、Mongodb数据库保存数据

26、主从服务器分布式采集

更新日志

优采云采集器v7.6 绿色正式版更新列表:

1、gif图片不再加水印。修复添加水印文本时不判断水印条件的问题;

2、 新增迅雷快传、云文件、千脑、金山网盘的文件上传功能;

3、 增加了用户在删除记录时选择是否删除下载文件的选项;

4、 添加日志记录,通过上传文件功能;

5、新增批量导入数据导入URL功能;

6、 新增发布时代理功能;

7、修复了使用一般的side-posting方式保存为本地excel不生效的问题;

8、 文件保存格式支持[Tag:ID],记录的id可以作为目录的一部分;

9、 处理了$编码错误的问题;

10、添加几个错误检查,防止采集器退出;

11、 将汉字替换为拼音字典,汉字增加到18000个;

12、更新自动补全链接中迅雷地址补全错误的问题。

软件安装说明:

优采云采集 平台定义了统一的接口规范,并提供了大量的API。用户可以轻松开发自己的应用程序并在平台上运行,可以减少开发时间和成本。目前平台有官方内置的优采云采集器。

本软件版本为优采云采集器v7.7绿色正式版,下载软件后直接解压即可。注意:软件运行时,必须有.net2.0帧,vista和win7系统用户可能会提示请求管理员权限,请放手。如果没有,请下载!

安装说明★★

优采云数据采集 平台要求:您的计算机必须具有.net框架2.0或2.0或更高版本。如果你的采集器打不开,请下载安装框架

附加 windows .net 框架 2.0

32位下载地址:

64位下载地址:

升级说明

直接从3.2sp5、2008、2009或2010版本升级到优采云data采集平台最新版本,请运行程序目录下的UpdateToV7.exe并按照提示升级。升级程序不会对原有数据做任何改动,但为防止用户误操作,升级前请备份旧版本数据和配置。备份方法是将原创采集器 做一个完整的副本。

采集相关术语

1.采集 规则

简称规则,V7之前版本的采集规则分为站点规则和任务规则,通常是指任务规则。V7及以后版本采用无级分组管理任务规则,不再有站点规则的概念。所谓采集规则就是采集一个网站或者某个网站栏目网页需要在软件中设置。该设置可以从软件中导出,保存为文件,然后导入到软件中。V7版本的任务规则文件的后缀是.ljobx,之前的站点规则文件的后缀是:.lsite;任务规则文件的后缀是.ljob。

2.采集任务

采集 任务也简称为任务。它是 采集 规则和发布规则的总和。也是采集规则和发布规则的载体。采集在任务编辑框中设置规则和发布规则。从采集器 导出的采集 规则文件(带有.ljobx 后缀)也可以称为任务规则。导入导出任务规则是指导导入导出.ljobx文件。

3.发布模块

发布模块,又称模块和发布规则,分为WEB发布模块和数据库发布模块。所谓发布模块,就是当已经采集的数据需要发布到目的地(例如:网站/在后台或指定的数据库中)时,软件中的设置。这个设置可以保存为文件,可以导入到采集器中使用。数据库发布模块文件后缀为.dpm;WEB在线发布模块文件后缀为.wpm。(采集规则和发布模块可以从采集器中导出,也可以导入到采集器中使用。采集规则负责网页上的数据采集接下来,发布模块负责将采集的数据发布到网站。可以看出,采集的规则的编写和修改与采集的网站有关,而release模块的编译和修改与网站有关@> 要发布的数据。例如,从不同的网站列采集数据到同一网站的某一段(在频道中发布),需要多个采集规则和一个发布模块. 要将一个网站列采集的数据发布到不同的网站系统,需要一个采集规则和多个发布模块。注意这里提到的采集规则是指采集网站的设置和要抓取的内容。)与采集的网站有关,而发布模块的编译和修改与要发布的数据的网站有关。例如,从不同的网站列采集数据到同一网站的某一段(在频道中发布),需要多个采集规则和一个发布模块. 要将一个网站列采集的数据发布到不同的网站系统,需要一个采集规则和多个发布模块。注意这里提到的采集规则是指采集网站的设置和要抓取的内容。)与采集的网站有关,而发布模块的编译和修改与要发布的数据的网站有关。例如,从不同的网站列采集数据到同一网站的某一段(在频道中发布),需要多个采集规则和一个发布模块. 要将一个网站列采集的数据发布到不同的网站系统,需要一个采集规则和多个发布模块。注意这里提到的采集规则是指采集网站的设置和要抓取的内容。)从不同的网站列采集数据到同一网站的某一段(在频道中发布),需要多个采集规则和一个发布模块。要将一个网站列采集的数据发布到不同的网站系统,需要一个采集规则和多个发布模块。注意这里提到的采集规则是指采集网站的设置和要抓取的内容。)从不同的网站列采集数据到同一网站的某一段(在频道中发布),需要多个采集规则和一个发布模块。要将一个网站列采集的数据发布到不同的网站系统,需要一个采集规则和多个发布模块。注意这里提到的采集规则是指采集网站的设置和要抓取的内容。)