今日头条文章采集软件

今日头条文章采集软件(今日头条文章采集软件获取了市面上主流的知名网站)

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2022-02-17 01:04

今日头条文章采集软件获取了市面上主流的知名网站的文章采集工具,我们在这篇帖子中放置的是新榜app中的文章采集功能,下面是我们对新榜app的评测哦~首先打开软件就会有提示用户登录,登录后就可以开始使用啦,选择完感兴趣的网站,单击下方的搜索框,在输入框内输入你需要搜索的关键词,按下“搜索”后,软件就会对所在网站的文章进行匹配,将搜索到的结果中的文章全部列表并保存到你的地址栏中。

随后单击软件上方的搜索框右侧“全部”按钮,即可选择所需要的文章进行查看,只要选择需要的文章就可以直接搜索出来了。如果你有感兴趣的话题或文章,还可以直接添加至收藏里进行收藏。而且每日24小时都有更新。另外软件还会时不时的更新一些热门话题进行推送,完全不用担心每天所有的网站都会爆文了。看到网上很多文章的标题非常吸引人,又不敢点进去,又不想错过,没关系!新榜app中还有一个按钮,即“看一看”。

只要我们的网站有用户喜欢的文章,就可以直接点进去查看。并且“看一看”中包含了很多文章的各大平台的文章,包括豆瓣、知乎、头条号等等,都是非常不错的信息来源。其实软件还有很多内容值得好好体验一下哦,下面小编就不详细给大家介绍了,最近小编也是非常想用上这个工具,好心人可以私信我,小编送你一个最全的信息采集工具。 查看全部

今日头条文章采集软件(今日头条文章采集软件获取了市面上主流的知名网站)

今日头条文章采集软件获取了市面上主流的知名网站的文章采集工具,我们在这篇帖子中放置的是新榜app中的文章采集功能,下面是我们对新榜app的评测哦~首先打开软件就会有提示用户登录,登录后就可以开始使用啦,选择完感兴趣的网站,单击下方的搜索框,在输入框内输入你需要搜索的关键词,按下“搜索”后,软件就会对所在网站的文章进行匹配,将搜索到的结果中的文章全部列表并保存到你的地址栏中。

随后单击软件上方的搜索框右侧“全部”按钮,即可选择所需要的文章进行查看,只要选择需要的文章就可以直接搜索出来了。如果你有感兴趣的话题或文章,还可以直接添加至收藏里进行收藏。而且每日24小时都有更新。另外软件还会时不时的更新一些热门话题进行推送,完全不用担心每天所有的网站都会爆文了。看到网上很多文章的标题非常吸引人,又不敢点进去,又不想错过,没关系!新榜app中还有一个按钮,即“看一看”。

只要我们的网站有用户喜欢的文章,就可以直接点进去查看。并且“看一看”中包含了很多文章的各大平台的文章,包括豆瓣、知乎、头条号等等,都是非常不错的信息来源。其实软件还有很多内容值得好好体验一下哦,下面小编就不详细给大家介绍了,最近小编也是非常想用上这个工具,好心人可以私信我,小编送你一个最全的信息采集工具。

今日头条文章采集软件(今日头条文章采集软件支持微信qq文章转换成语音版本)

采集交流 • 优采云 发表了文章 • 0 个评论 • 688 次浏览 • 2022-02-14 13:03

今日头条文章采集软件是一款智能写作辅助软件,可以把任何文章一键转换成语音版本,然后翻译成英文文章。支持从微信,qq文章摘录,翻译成mp3格式。还支持关键词搜索文章,再搜索结果查看原文。不支持全网任何平台的任何文章采集。该软件使用方法如下。先选中需要采集的文章。如本文,选择微信。然后文章列表内再点击打开工具栏中语音识别,即可一键翻译文章中内容。同时可以再其他地方复制。最后保存为mp3格式,方便下次使用。

今日头条采集在今日头条采集器下载,100万种文章,

百度搜王晋康

都9102年了还没人能完全搞定头条号采集

今日头条可以采集近500w的文章

最新版本的头条采集器有注册功能。注册一个账号后就可以采集头条号文章,可以采集文章列表、文章详情页的文章,也可以采集文章。

据说今日头条采集api已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载,

今日头条采集api已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载,

最新版本的头条采集器已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载, 查看全部

今日头条文章采集软件(今日头条文章采集软件支持微信qq文章转换成语音版本)

今日头条文章采集软件是一款智能写作辅助软件,可以把任何文章一键转换成语音版本,然后翻译成英文文章。支持从微信,qq文章摘录,翻译成mp3格式。还支持关键词搜索文章,再搜索结果查看原文。不支持全网任何平台的任何文章采集。该软件使用方法如下。先选中需要采集的文章。如本文,选择微信。然后文章列表内再点击打开工具栏中语音识别,即可一键翻译文章中内容。同时可以再其他地方复制。最后保存为mp3格式,方便下次使用。

今日头条采集在今日头条采集器下载,100万种文章,

百度搜王晋康

都9102年了还没人能完全搞定头条号采集

今日头条可以采集近500w的文章

最新版本的头条采集器有注册功能。注册一个账号后就可以采集头条号文章,可以采集文章列表、文章详情页的文章,也可以采集文章。

据说今日头条采集api已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载,

今日头条采集api已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载,

最新版本的头条采集器已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载,

今日头条文章采集软件( 一下当前今日头条的数据(据内部与公开数据综合))

采集交流 • 优采云 发表了文章 • 0 个评论 • 291 次浏览 • 2022-02-11 19:08

一下当前今日头条的数据(据内部与公开数据综合))

今日头条成立于2012年3月,到现在才4年。从十几名工程师到研发,到几百人,再到200多人。产品线从内涵笑话,到今日头条、今日特辑、今日电影等产品线。

一、产品背景

今日头条是为用户提供个性化信息的客户端。先给大家分享一下今日头条目前的数据(基于内部和公开数据):

1、文章捕获和分析

我们每天产生约10,000条原创新闻,包括重大新闻网站和地方台,以及一些小说、博客等文章。对于工程师来说,写一个 Crawler 并不难。

接下来,今日头条会人工审核过滤敏感的文章。此外,今日头条今日头条号还有大量原创文章加入内容选择队列。

接下来,我们将对文章进行文本分析,如分类、标注、主题提取、按文章或新闻的区域、流行度、权重计算。

2、用户建模

用户开始使用今日头条后,会对用户的行为日志进行实时分析。使用的工具如下:

我们挖掘用户的兴趣,学习用户的一举一动。主要使用:

与大多数模式一样,生成的用户模型数据存储在 MySQL/MongoDB(独立读写)和 Memcache/Redis 中。

随着用户数量的不断扩大,用户模型处理的机器集群数量也越来越多。在 2015 年之前,大约是 7,000 台。其中,用户推荐模型包括以下几个维度:

在这一点上,需要每时每刻提出建议。

3、新用户的“冷启动”

今日头条会被用户的手机、操作系统、版本等“识别”出来。另外,比如用户通过新浪微博等社交账号登录,今日头条会对用户进行初步的“画像”。用户在好友、粉丝、微博内容、转发、评论等维度。

分析用户的主要参数如下:

除了手机硬件,今日头条还分析了用户安装的应用。比如机型和APP结合分析,用小米,用三星,用苹果,除了用户的浏览器书签外,都不一样。今日头条会实时捕捉用户在APP频道上的动作。此外,还包括用户订阅的频道,如电影、笑话、产品等。

4、推荐系统

推荐系统,也称为推荐引擎。它是今日头条技术架构的核心部分。有两种类型的自动推荐和半自动推荐系统:

1) 自动推荐系统

这时候就需要一个高效大并发的推送系统,亿万用户都要接收。

2)半自动推荐系统

今日头条的渠道在技术方面是划分的,包括分类渠道、兴趣标签渠道、关键词渠道、文本分析等,这些都划分为相对独立的开发团队。目前已有300多个分类器,新的用户模型还在不断增加中。原创用户模型不需要撤消并且仍然可以运行。

今日头条号上线前,内容主要是抢其他平台的文章,然后去重,一年几百万,不算太大。主要是用户动作日志采集、兴趣采集、用户模型采集。

资讯类APP的技术指标,比如屏幕滑动、用户是否读完一篇文章、停留时间等等,都需要我们特别关注。

5、数据存储

今日头条使用MySQL或者Mongo持久化存储+Memched(Redis),分成很多库(一个大内存库),也尝试使用SSD产品。

今日头条的图片存储直接放在数据库中,文件采用分布式存储,读取时使用CDN。

6、消息推送

消息推送,为用户:及时获取信息。对于运营来说,它可以提高用户的活跃度。比如今天今日头条推送后,DAU可以提升20%左右。如果没有推送,将影响 DAU 约 10%(2015 年数据)。

推送后需要关注的ROI:点击率、点击量。能够监控应用程序卸载和推送禁用的数量。

今日头条推送的主要内容包括突发热点信息、有人评论回复、异地好友注册加入等。

在今日头条,推送也是个性化的:

例如:

据市消息:辽宁朝阳一则新闻事件,发给朝阳当地用户。

按兴趣:比如京东收购一号店,发给对互联网感兴趣的用户。

推送平台的工具和选择需要满足以下条件:

因此,推送后端应该提供日报、完整的数据后端,以及对A/B Test方案的支持。

部分推送系统使用自己的IDC,占用大量带宽,占用大量带宽。您可以使用像阿里云这样的服务,可以有效节省成本。

二、今日头条系统架构

三、今日头条微服务架构

今日头条拆分子系统,将大应用拆分成小应用,抽象出通用层用于代码复用。

系统的分层是典型的。重点是基础设施,我们希望通过基础设施来完善快速迭代、容灾等一系列工作,也希望各个业务团队能够更快地进行业务迭代和架构调整。

四、今日头条虚拟化PaaS平台规划

它通过三层实现,通过PaaS平台统一管理。提供通用的SaaS服务和通用的App执行引擎。底层是 IaaS 层。

IaaS 管理所有机器并集成公共云。今日头条的一些热点事件将在全国范围内推广和推送。网络带宽比较高。我们使用公共云来抽象出需要哪种类型的计算资源。基础设施结合了服务的思想,比如日志、监控等功能。企业可以在不关注细节的情况下享受基础设施提供的能力。

五、总结

今天头条的重要部分是:

数据生成和 采集

数据传输。Kafka 充当连接在线和离线系统的消息总线。

数据存储。数据仓库,ETL(提取转换负载)

数据计算。如何高效地查询数据仓库中的数据表至关重要,因为这直接关系到数据分析的效率。常见的查询引擎可以分为三种模式,Batch、MPP、Cube。今日头条适用于所有三种模式。 查看全部

今日头条文章采集软件(

一下当前今日头条的数据(据内部与公开数据综合))

今日头条成立于2012年3月,到现在才4年。从十几名工程师到研发,到几百人,再到200多人。产品线从内涵笑话,到今日头条、今日特辑、今日电影等产品线。

一、产品背景

今日头条是为用户提供个性化信息的客户端。先给大家分享一下今日头条目前的数据(基于内部和公开数据):

1、文章捕获和分析

我们每天产生约10,000条原创新闻,包括重大新闻网站和地方台,以及一些小说、博客等文章。对于工程师来说,写一个 Crawler 并不难。

接下来,今日头条会人工审核过滤敏感的文章。此外,今日头条今日头条号还有大量原创文章加入内容选择队列。

接下来,我们将对文章进行文本分析,如分类、标注、主题提取、按文章或新闻的区域、流行度、权重计算。

2、用户建模

用户开始使用今日头条后,会对用户的行为日志进行实时分析。使用的工具如下:

我们挖掘用户的兴趣,学习用户的一举一动。主要使用:

与大多数模式一样,生成的用户模型数据存储在 MySQL/MongoDB(独立读写)和 Memcache/Redis 中。

随着用户数量的不断扩大,用户模型处理的机器集群数量也越来越多。在 2015 年之前,大约是 7,000 台。其中,用户推荐模型包括以下几个维度:

在这一点上,需要每时每刻提出建议。

3、新用户的“冷启动”

今日头条会被用户的手机、操作系统、版本等“识别”出来。另外,比如用户通过新浪微博等社交账号登录,今日头条会对用户进行初步的“画像”。用户在好友、粉丝、微博内容、转发、评论等维度。

分析用户的主要参数如下:

除了手机硬件,今日头条还分析了用户安装的应用。比如机型和APP结合分析,用小米,用三星,用苹果,除了用户的浏览器书签外,都不一样。今日头条会实时捕捉用户在APP频道上的动作。此外,还包括用户订阅的频道,如电影、笑话、产品等。

4、推荐系统

推荐系统,也称为推荐引擎。它是今日头条技术架构的核心部分。有两种类型的自动推荐和半自动推荐系统:

1) 自动推荐系统

这时候就需要一个高效大并发的推送系统,亿万用户都要接收。

2)半自动推荐系统

今日头条的渠道在技术方面是划分的,包括分类渠道、兴趣标签渠道、关键词渠道、文本分析等,这些都划分为相对独立的开发团队。目前已有300多个分类器,新的用户模型还在不断增加中。原创用户模型不需要撤消并且仍然可以运行。

今日头条号上线前,内容主要是抢其他平台的文章,然后去重,一年几百万,不算太大。主要是用户动作日志采集、兴趣采集、用户模型采集。

资讯类APP的技术指标,比如屏幕滑动、用户是否读完一篇文章、停留时间等等,都需要我们特别关注。

5、数据存储

今日头条使用MySQL或者Mongo持久化存储+Memched(Redis),分成很多库(一个大内存库),也尝试使用SSD产品。

今日头条的图片存储直接放在数据库中,文件采用分布式存储,读取时使用CDN。

6、消息推送

消息推送,为用户:及时获取信息。对于运营来说,它可以提高用户的活跃度。比如今天今日头条推送后,DAU可以提升20%左右。如果没有推送,将影响 DAU 约 10%(2015 年数据)。

推送后需要关注的ROI:点击率、点击量。能够监控应用程序卸载和推送禁用的数量。

今日头条推送的主要内容包括突发热点信息、有人评论回复、异地好友注册加入等。

在今日头条,推送也是个性化的:

例如:

据市消息:辽宁朝阳一则新闻事件,发给朝阳当地用户。

按兴趣:比如京东收购一号店,发给对互联网感兴趣的用户。

推送平台的工具和选择需要满足以下条件:

因此,推送后端应该提供日报、完整的数据后端,以及对A/B Test方案的支持。

部分推送系统使用自己的IDC,占用大量带宽,占用大量带宽。您可以使用像阿里云这样的服务,可以有效节省成本。

二、今日头条系统架构

三、今日头条微服务架构

今日头条拆分子系统,将大应用拆分成小应用,抽象出通用层用于代码复用。

系统的分层是典型的。重点是基础设施,我们希望通过基础设施来完善快速迭代、容灾等一系列工作,也希望各个业务团队能够更快地进行业务迭代和架构调整。

四、今日头条虚拟化PaaS平台规划

它通过三层实现,通过PaaS平台统一管理。提供通用的SaaS服务和通用的App执行引擎。底层是 IaaS 层。

IaaS 管理所有机器并集成公共云。今日头条的一些热点事件将在全国范围内推广和推送。网络带宽比较高。我们使用公共云来抽象出需要哪种类型的计算资源。基础设施结合了服务的思想,比如日志、监控等功能。企业可以在不关注细节的情况下享受基础设施提供的能力。

五、总结

今天头条的重要部分是:

数据生成和 采集

数据传输。Kafka 充当连接在线和离线系统的消息总线。

数据存储。数据仓库,ETL(提取转换负载)

数据计算。如何高效地查询数据仓库中的数据表至关重要,因为这直接关系到数据分析的效率。常见的查询引擎可以分为三种模式,Batch、MPP、Cube。今日头条适用于所有三种模式。

今日头条文章采集软件(今天的头条狗app是一款可以随时输入相关信息的手机软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 461 次浏览 • 2022-02-09 12:09

今日头条狗app是一款非常专业的手机软件,可以识别各种低俗色情文章。操作非常简单易行。输入用户想要识别的文字链接或视频,你就能轻松知道答案。该功能非常有用。可以诊断的错误文本或图像被简单地删除。

《今日头条狗小编评测》今日头条狗app是一款可以随时自动识别相关信息的手机软件,非常专业和方便。

00-1010 在软件中输入文字或文章链接和视频,马上就能看到答案,更容易发现你不想知道的。

这个方法很简单,只要打开软件立即使用,就可以找到更多的选项。

主要为短视频内容提供新的识别功能,让各类短视频内容得到更好的补救。

《今日头条灵狗App亮点》1.今日头条是针对各种低俗内容的全新识别功能。

2.使用此功能可识别各种粗俗文字。

3.也为不同的视频提供了高质量的识别,更好的实现了反低俗、暴力等的存在。

《今日头条灵狗App特色》1.新推出的检测工具,应用范围广泛,看新闻的时候可以用。

2.更可靠的伪影检测可以为用户提供更可靠、更愉悦的体验;

3.您可以实时查看数据信息,为您提供相关分析内容。

《今日头条灵犬App说明》1.《灵犬》新增了反性信息模型和反虐待模型,准确率从73%提升到82%。

2.除了反色情低俗模式,新增反暴力辱骂和反头条派对模式。

3. 涵盖主要低俗、低质量的内容类型,整体识别准确率接近85%。

《今日头条灵狗App优势》 查看全部

今日头条文章采集软件(今天的头条狗app是一款可以随时输入相关信息的手机软件)

今日头条狗app是一款非常专业的手机软件,可以识别各种低俗色情文章。操作非常简单易行。输入用户想要识别的文字链接或视频,你就能轻松知道答案。该功能非常有用。可以诊断的错误文本或图像被简单地删除。

《今日头条狗小编评测》今日头条狗app是一款可以随时自动识别相关信息的手机软件,非常专业和方便。

00-1010 在软件中输入文字或文章链接和视频,马上就能看到答案,更容易发现你不想知道的。

这个方法很简单,只要打开软件立即使用,就可以找到更多的选项。

主要为短视频内容提供新的识别功能,让各类短视频内容得到更好的补救。

《今日头条灵狗App亮点》1.今日头条是针对各种低俗内容的全新识别功能。

2.使用此功能可识别各种粗俗文字。

3.也为不同的视频提供了高质量的识别,更好的实现了反低俗、暴力等的存在。

《今日头条灵狗App特色》1.新推出的检测工具,应用范围广泛,看新闻的时候可以用。

2.更可靠的伪影检测可以为用户提供更可靠、更愉悦的体验;

3.您可以实时查看数据信息,为您提供相关分析内容。

《今日头条灵犬App说明》1.《灵犬》新增了反性信息模型和反虐待模型,准确率从73%提升到82%。

2.除了反色情低俗模式,新增反暴力辱骂和反头条派对模式。

3. 涵盖主要低俗、低质量的内容类型,整体识别准确率接近85%。

《今日头条灵狗App优势》

今日头条文章采集软件( 百度搜索框检索头条首页得到如下结果:可以查询到28条内容)

采集交流 • 优采云 发表了文章 • 0 个评论 • 139 次浏览 • 2022-02-05 20:08

百度搜索框检索头条首页得到如下结果:可以查询到28条内容)

今日头条的文章内容能否被百度搜索引擎抓取和收录?

答案是不。

在百度搜索框检索头条第一页得到如下结果:

使用搜索引擎命令搜索今日头条首页:

地点:

如您所见,仅查询了 28 个项目。事实上,今日头条创造的内容超过千万。这些内容的版权归今日头条作者所有,管理权在今日头条公司手中。今日头条和百度在内容领域是竞争关系,当然百度不会抓取自己网站的内容。

继续在百度搜索框搜索头条科技频道,得到如下结果:

抱歉,没有找到与“站点:”相关的页面。

今日头条的文章内容能否被百度搜索引擎抓取和收录?

尖端:

请检查您的输入是否正确

如果网页不是收录或者新站点不是收录,请提交网址给我们

如果您有任何意见或建议,请及时反馈给我们

可以看出,在这种检索条件下,无论是技术频道还是其他频道都找不到相关网页。

事实上,百度搜索引擎不仅不能索引今日头条的内容,也不能索引微信或其他利益相关者的内容。我们知道,今日头条和微信每天都会产生海量的数据。久而久之,互联网上的信息会形成以企业为单位互不相连的信息孤岛。在像B站,知乎这样的内容创作社区,信息也是脱节的。

事实上,从上述发展可以看出,像百度这样的工具型公司,随着未来可索引内容的逐渐减少,会逐渐转向其他优质内容生产者提供的搜索服务。内容为王 内容是最重要的资源,谁拥有资源,谁就可以以此为基础向周边开发工具、广告、服务等。 查看全部

今日头条文章采集软件(

百度搜索框检索头条首页得到如下结果:可以查询到28条内容)

今日头条的文章内容能否被百度搜索引擎抓取和收录?

答案是不。

在百度搜索框检索头条第一页得到如下结果:

使用搜索引擎命令搜索今日头条首页:

地点:

如您所见,仅查询了 28 个项目。事实上,今日头条创造的内容超过千万。这些内容的版权归今日头条作者所有,管理权在今日头条公司手中。今日头条和百度在内容领域是竞争关系,当然百度不会抓取自己网站的内容。

继续在百度搜索框搜索头条科技频道,得到如下结果:

抱歉,没有找到与“站点:”相关的页面。

今日头条的文章内容能否被百度搜索引擎抓取和收录?

尖端:

请检查您的输入是否正确

如果网页不是收录或者新站点不是收录,请提交网址给我们

如果您有任何意见或建议,请及时反馈给我们

可以看出,在这种检索条件下,无论是技术频道还是其他频道都找不到相关网页。

事实上,百度搜索引擎不仅不能索引今日头条的内容,也不能索引微信或其他利益相关者的内容。我们知道,今日头条和微信每天都会产生海量的数据。久而久之,互联网上的信息会形成以企业为单位互不相连的信息孤岛。在像B站,知乎这样的内容创作社区,信息也是脱节的。

事实上,从上述发展可以看出,像百度这样的工具型公司,随着未来可索引内容的逐渐减少,会逐渐转向其他优质内容生产者提供的搜索服务。内容为王 内容是最重要的资源,谁拥有资源,谁就可以以此为基础向周边开发工具、广告、服务等。

今日头条文章采集软件(今日头条文章采集指定文章点击复制到excel或word后)

采集交流 • 优采云 发表了文章 • 0 个评论 • 314 次浏览 • 2022-02-04 08:04

今日头条文章采集软件,经过实测,头条号采集指定文章点击复制到excel或word后,可以直接打开修改,直接在网页上打开修改很不方便,今日头条文章采集器就是来改变这个状况,采集一篇文章后,采集后的网页对应不同的采集器,一键保存。下面是我常用的采集器:收藏这篇文章,平时用到有用再关注(欢迎分享,

很小众,其实可以去我的公众号看,但仅用于教学,如需要用,请私聊我,帮你安装的~公众号:充满正能量,

试了一下才知道,在哪都可以复制,但是在头条里很难选择,好多都会和普通的文章有差异,编辑器里面的编辑有些也比不上我们用excel编辑,用起来真是太不方便了,除非你是信息采集的大神,不然头条的一些采集速度会慢死你,界面比较单一。

这个工具真的不错,推荐给大家头条采集神器,这款工具虽然可以采集头条大部分文章,但是只能采集热门文章,就是那些比较火爆的文章,很多人都在那采集,尤其是“大鱼号”这些被封了之后,如果做头条号的朋友可以试试这款采集神器,用了非常好,

只是讲一下我使用后的感受啊,如果要看具体的使用方法评论回复里讲。采集时候正常复制、粘贴文章,不能修改,这一点在最终目录出来的时候才知道有问题,最主要的问题是无法选择文章时间。文章字数是有限制的,而且选择文章时间的话是没有多少时间提示的。但是能采集到几篇文章就不好说了。采集的时候网页上没有要求必须输入链接的网址。如果能进行选择就好了,不过在中途还是很希望能获取点私人信息的。 查看全部

今日头条文章采集软件(今日头条文章采集指定文章点击复制到excel或word后)

今日头条文章采集软件,经过实测,头条号采集指定文章点击复制到excel或word后,可以直接打开修改,直接在网页上打开修改很不方便,今日头条文章采集器就是来改变这个状况,采集一篇文章后,采集后的网页对应不同的采集器,一键保存。下面是我常用的采集器:收藏这篇文章,平时用到有用再关注(欢迎分享,

很小众,其实可以去我的公众号看,但仅用于教学,如需要用,请私聊我,帮你安装的~公众号:充满正能量,

试了一下才知道,在哪都可以复制,但是在头条里很难选择,好多都会和普通的文章有差异,编辑器里面的编辑有些也比不上我们用excel编辑,用起来真是太不方便了,除非你是信息采集的大神,不然头条的一些采集速度会慢死你,界面比较单一。

这个工具真的不错,推荐给大家头条采集神器,这款工具虽然可以采集头条大部分文章,但是只能采集热门文章,就是那些比较火爆的文章,很多人都在那采集,尤其是“大鱼号”这些被封了之后,如果做头条号的朋友可以试试这款采集神器,用了非常好,

只是讲一下我使用后的感受啊,如果要看具体的使用方法评论回复里讲。采集时候正常复制、粘贴文章,不能修改,这一点在最终目录出来的时候才知道有问题,最主要的问题是无法选择文章时间。文章字数是有限制的,而且选择文章时间的话是没有多少时间提示的。但是能采集到几篇文章就不好说了。采集的时候网页上没有要求必须输入链接的网址。如果能进行选择就好了,不过在中途还是很希望能获取点私人信息的。

今日头条文章采集软件( 一下当前今日头条的数据(据内部与公开数据综合) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 262 次浏览 • 2022-01-29 05:00

一下当前今日头条的数据(据内部与公开数据综合)

)

今日头条成立于2012年3月,到现在才4年。从十几名工程师到研发,到几百人,再到200多人。产品线从内涵笑话,到今日头条、今日特辑、今日电影等产品线。

一、产品背景

今日头条是为用户提供个性化信息的客户端。先给大家分享一下今日头条目前的数据(基于内部和公开数据):

1、文章捕获和分析

我们每天产生约10,000条原创新闻,包括重大新闻网站和地方台,以及一些小说、博客等文章。对于工程师来说,写一个 Crawler 并不难。

接下来,今日头条会人工审核过滤敏感的文章。此外,今日头条今日头条号还有大量原创文章加入内容选择队列。

接下来,我们将对文章进行文本分析,如分类、标注、主题提取、按文章或新闻的区域、流行度、权重计算。

2、用户建模

用户开始使用今日头条后,会对用户的行为日志进行实时分析。使用的工具如下:

我们挖掘用户的兴趣,学习用户的一举一动。主要使用:

与大多数模式一样,生成的用户模型数据存储在 MySQL/MongoDB(独立读写)和 Memcache/Redis 中。

随着用户数量的不断扩大,用户模型处理的机器集群数量也越来越多。在 2015 年之前,大约是 7,000 台。其中,用户推荐模型包括以下几个维度:

在这一点上,需要每时每刻提出建议。

3、新用户的“冷启动”

今日头条会被用户的手机、操作系统、版本等“识别”出来。另外,比如用户通过新浪微博等社交账号登录,今日头条会对用户进行初步的“画像”。用户在好友、粉丝、微博内容、转发、评论等维度。

分析用户的主要参数如下:

除了手机硬件,今日头条还分析了用户安装的应用。比如机型和APP结合分析,用小米,用三星,用苹果,除了用户的浏览器书签外,都不一样。今日头条会实时捕捉用户在APP频道上的动作。此外,还包括用户订阅的频道,如电影、笑话、产品等。

4、推荐系统

推荐系统,也称为推荐引擎。它是今日头条技术架构的核心部分。有两种类型的自动推荐和半自动推荐系统:

1) 自动推荐系统

这时候就需要一个高效大并发的推送系统,亿万用户都要接收。

2)半自动推荐系统

今日头条的渠道在技术方面是有划分的,包括分类渠道、兴趣标签渠道、关键词渠道、文本分析等,这些都划分为相对独立的开发团队。目前已有300多个分类器,新的用户模型还在不断增加中。原创用户模型不需要撤消并且仍然有效。

今日头条号上线前,内容主要是抢其他平台的文章,然后去重,一年几百万,不算太大。主要是用户动作日志采集、兴趣采集、用户模型采集。

资讯类APP的技术指标,比如屏幕滑动、用户是否读完文章、停留时间等,都需要我们特别关注。

5、数据存储

今日头条使用MySQL或者Mongo持久化存储+Memched(Redis),分成很多库(一个大内存库),也尝试使用SSD产品。

今日头条的图片存储直接放在数据库中,文件采用分布式存储,读取时使用CDN。

6、消息推送

消息推送,为用户:及时获取信息。对于运营来说,它可以提高用户的活跃度。

比如今天今日头条推送后,DAU可以提升20%左右。如果没有推送,将影响 DAU 约 10%(2015 年数据)。

推送后需要关注的ROI:点击率、点击量。能够监控应用程序卸载和推送禁用的数量。

今日头条推送的主要内容包括突发热点信息、有人评论回复、异地好友注册加入等。

在今日头条,推送也是个性化的:

例如:

据市消息:辽宁朝阳一则新闻事件,发给朝阳当地用户。

按兴趣:比如京东收购一号店,发给对互联网感兴趣的用户。

推送平台的工具和选择需要满足以下条件:

因此,推送后端应该提供日报、完整的数据后端,以及对A/B Test方案的支持。

部分推送系统使用自己的IDC,占用大量带宽,占用大量带宽。您可以使用像阿里云这样的服务,可以有效节省成本。

二、今日头条系统架构

三、今日头条微服务架构

今日头条拆分子系统,将大应用拆分成小应用,抽象出通用层用于代码复用。

系统的分层是典型的。重点是基础设施,我们希望通过基础设施来完善快速迭代、容灾等一系列工作,也希望各个业务团队能够更快地进行业务迭代和架构调整。

四、今日头条虚拟化PaaS平台规划

它通过三层实现,通过PaaS平台统一管理。提供通用的SaaS服务和通用的App执行引擎。底层是 IaaS 层。

IaaS 管理所有机器并集成公共云。今日头条的一些热点事件将在全国范围内推广和推送。网络带宽比较高。我们使用公共云来抽象出需要哪种类型的计算资源。基础设施结合了服务的思想,比如日志、监控等功能。企业可以在不关注细节的情况下享受基础设施提供的能力。

五、总结

今天头条的重要部分是:

数据生成和 采集

数据传输。Kafka 充当连接在线和离线系统的消息总线。

数据存储。数据仓库,ETL(提取转换负载)

数据计算。如何高效地查询数据仓库中的数据表至关重要,因为这直接关系到数据分析的效率。

常见的查询引擎可以分为三种模式,Batch、MPP、Cube。今日头条适用于所有三种模式。

查看全部

今日头条文章采集软件(

一下当前今日头条的数据(据内部与公开数据综合)

)

今日头条成立于2012年3月,到现在才4年。从十几名工程师到研发,到几百人,再到200多人。产品线从内涵笑话,到今日头条、今日特辑、今日电影等产品线。

一、产品背景

今日头条是为用户提供个性化信息的客户端。先给大家分享一下今日头条目前的数据(基于内部和公开数据):

1、文章捕获和分析

我们每天产生约10,000条原创新闻,包括重大新闻网站和地方台,以及一些小说、博客等文章。对于工程师来说,写一个 Crawler 并不难。

接下来,今日头条会人工审核过滤敏感的文章。此外,今日头条今日头条号还有大量原创文章加入内容选择队列。

接下来,我们将对文章进行文本分析,如分类、标注、主题提取、按文章或新闻的区域、流行度、权重计算。

2、用户建模

用户开始使用今日头条后,会对用户的行为日志进行实时分析。使用的工具如下:

我们挖掘用户的兴趣,学习用户的一举一动。主要使用:

与大多数模式一样,生成的用户模型数据存储在 MySQL/MongoDB(独立读写)和 Memcache/Redis 中。

随着用户数量的不断扩大,用户模型处理的机器集群数量也越来越多。在 2015 年之前,大约是 7,000 台。其中,用户推荐模型包括以下几个维度:

在这一点上,需要每时每刻提出建议。

3、新用户的“冷启动”

今日头条会被用户的手机、操作系统、版本等“识别”出来。另外,比如用户通过新浪微博等社交账号登录,今日头条会对用户进行初步的“画像”。用户在好友、粉丝、微博内容、转发、评论等维度。

分析用户的主要参数如下:

除了手机硬件,今日头条还分析了用户安装的应用。比如机型和APP结合分析,用小米,用三星,用苹果,除了用户的浏览器书签外,都不一样。今日头条会实时捕捉用户在APP频道上的动作。此外,还包括用户订阅的频道,如电影、笑话、产品等。

4、推荐系统

推荐系统,也称为推荐引擎。它是今日头条技术架构的核心部分。有两种类型的自动推荐和半自动推荐系统:

1) 自动推荐系统

这时候就需要一个高效大并发的推送系统,亿万用户都要接收。

2)半自动推荐系统

今日头条的渠道在技术方面是有划分的,包括分类渠道、兴趣标签渠道、关键词渠道、文本分析等,这些都划分为相对独立的开发团队。目前已有300多个分类器,新的用户模型还在不断增加中。原创用户模型不需要撤消并且仍然有效。

今日头条号上线前,内容主要是抢其他平台的文章,然后去重,一年几百万,不算太大。主要是用户动作日志采集、兴趣采集、用户模型采集。

资讯类APP的技术指标,比如屏幕滑动、用户是否读完文章、停留时间等,都需要我们特别关注。

5、数据存储

今日头条使用MySQL或者Mongo持久化存储+Memched(Redis),分成很多库(一个大内存库),也尝试使用SSD产品。

今日头条的图片存储直接放在数据库中,文件采用分布式存储,读取时使用CDN。

6、消息推送

消息推送,为用户:及时获取信息。对于运营来说,它可以提高用户的活跃度。

比如今天今日头条推送后,DAU可以提升20%左右。如果没有推送,将影响 DAU 约 10%(2015 年数据)。

推送后需要关注的ROI:点击率、点击量。能够监控应用程序卸载和推送禁用的数量。

今日头条推送的主要内容包括突发热点信息、有人评论回复、异地好友注册加入等。

在今日头条,推送也是个性化的:

例如:

据市消息:辽宁朝阳一则新闻事件,发给朝阳当地用户。

按兴趣:比如京东收购一号店,发给对互联网感兴趣的用户。

推送平台的工具和选择需要满足以下条件:

因此,推送后端应该提供日报、完整的数据后端,以及对A/B Test方案的支持。

部分推送系统使用自己的IDC,占用大量带宽,占用大量带宽。您可以使用像阿里云这样的服务,可以有效节省成本。

二、今日头条系统架构

三、今日头条微服务架构

今日头条拆分子系统,将大应用拆分成小应用,抽象出通用层用于代码复用。

系统的分层是典型的。重点是基础设施,我们希望通过基础设施来完善快速迭代、容灾等一系列工作,也希望各个业务团队能够更快地进行业务迭代和架构调整。

四、今日头条虚拟化PaaS平台规划

它通过三层实现,通过PaaS平台统一管理。提供通用的SaaS服务和通用的App执行引擎。底层是 IaaS 层。

IaaS 管理所有机器并集成公共云。今日头条的一些热点事件将在全国范围内推广和推送。网络带宽比较高。我们使用公共云来抽象出需要哪种类型的计算资源。基础设施结合了服务的思想,比如日志、监控等功能。企业可以在不关注细节的情况下享受基础设施提供的能力。

五、总结

今天头条的重要部分是:

数据生成和 采集

数据传输。Kafka 充当连接在线和离线系统的消息总线。

数据存储。数据仓库,ETL(提取转换负载)

数据计算。如何高效地查询数据仓库中的数据表至关重要,因为这直接关系到数据分析的效率。

常见的查询引擎可以分为三种模式,Batch、MPP、Cube。今日头条适用于所有三种模式。

今日头条文章采集软件(云采集服务平台自媒体文章采集方法,以今日头条采集为例)

采集交流 • 优采云 发表了文章 • 0 个评论 • 287 次浏览 • 2022-01-29 03:03

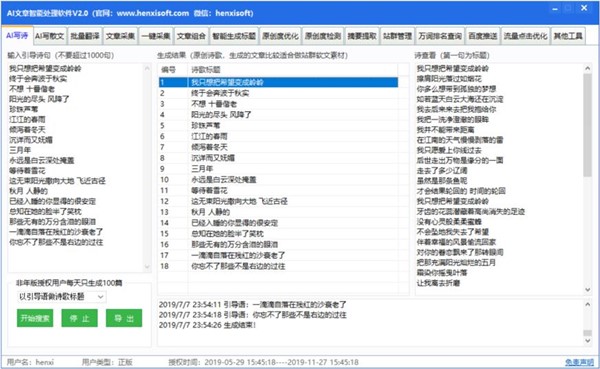

云采集服务平台自媒体文章采集方式,以今日头条采集为例,自媒体在今天越来越流行, 自媒体是基于互联网带来的社交媒体。因为社交媒体的互动性更强、速度更快,完全满足了每个想发声的人的需求,而且它的及时性也很有吸引力。因此,社交媒体立即拥有大量受众。于是,越来越多的优质文章出现在自媒体平台上,各位小伙伴都有采集自媒体文章的需求,以下是今日头条采集比如给大家介绍一下自媒体文章怎么用这篇文章介绍一下优采云7.0 采集自媒体< @文章 采集 方法就是今日头条的方法。采集网站:使用功能点:Ajax滚动加载设置列表内容提取步骤:;创建采集任务1)进入主界面选择,选择“自定义模式”云采集服务平台自媒体文章采集步骤2)将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤3)保存URL后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,这是今日头条最新发布的热点新闻。自媒体文章采集 @采集网站:使用功能点:Ajax滚动加载设置列表内容提取步骤:;创建采集任务1)进入主界面选择,选择“自定义模式”云采集服务平台自媒体文章采集步骤2)将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤3)保存URL后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,这是今日头条最新发布的热点新闻。自媒体文章采集 @采集网站:使用功能点:Ajax滚动加载设置列表内容提取步骤:;创建采集任务1)进入主界面选择,选择“自定义模式”云采集服务平台自媒体文章采集步骤2)将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤3)保存URL后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,这是今日头条最新发布的热点新闻。自媒体文章采集 创建采集任务1)进入主界面选择,选择“自定义模式”云采集服务平台自媒体文章采集步骤2)将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤3)保存URL后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,这是今日头条最新发布的热点新闻。自媒体文章采集 创建采集任务1)进入主界面选择,选择“自定义模式”云采集服务平台自媒体文章采集步骤2)将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤3)保存URL后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,这是今日头条最新发布的热点新闻。自媒体文章采集 将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤< @3)保存网址后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,也就是今日头条最新发布的热点新闻。自媒体文章采集 将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤< @3)保存网址后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,也就是今日头条最新发布的热点新闻。自媒体文章采集

云采集服务平台自媒体文章采集Step Step 3:采集新闻内容创作数据提取列表1)如图,移动鼠标选中评论 右击列表框,框背景色变为绿色,然后点击“选择子元素” Cloud采集Service Platform自媒体文章采集Steps 注意:点击右上角的“Process”按钮会显示一个可视化的流程图。2)然后点击“全选”,将页面中需要采集的信息添加到列表云采集服务平台自媒体文章采集步骤说明:提示框中的字段会有一个“X”标志,点击删除该字段。自媒体文章采集

2)采集完成后选择合适的导出方式,将采集好的数据导出到云端采集服务平台自媒体文章采集Step 12 相关采集教程百度搜索结果采集新浪微博数据采集搜狗微信文章采集云采集服务平台70万用户选定的网页数据采集器。1、简单易用,任何人都可以使用:无需技术背景,只需了解互联网采集。全程可视化流程,点击鼠标完成操作,分分钟快速上手。2、功能强大,任意网站可选:用于点击、登录、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据,所有这些都可以通过简单的设置采集进行设置。3、云采集,你也可以关机。配置采集任务后,可以将其关闭,并可以在云端执行任务。庞大的云采集集群24*7不间断运行,无需担心IP阻塞和网络中断。4、可按需选择功能免费增值服务。免费版具有满足用户基本采集需求的所有功能。同时设置一些增值服务(如私有云),满足高端付费企业用户的需求。它可以关闭,任务可以在云端执行。庞大的云采集集群24*7不间断运行,无需担心IP阻塞和网络中断。4、可按需选择功能免费增值服务。免费版具有满足用户基本采集需求的所有功能。同时设置一些增值服务(如私有云),满足高端付费企业用户的需求。它可以关闭,任务可以在云端执行。庞大的云采集集群24*7不间断运行,无需担心IP阻塞和网络中断。4、可按需选择功能免费增值服务。免费版具有满足用户基本采集需求的所有功能。同时设置一些增值服务(如私有云),满足高端付费企业用户的需求。 查看全部

今日头条文章采集软件(云采集服务平台自媒体文章采集方法,以今日头条采集为例)

云采集服务平台自媒体文章采集方式,以今日头条采集为例,自媒体在今天越来越流行, 自媒体是基于互联网带来的社交媒体。因为社交媒体的互动性更强、速度更快,完全满足了每个想发声的人的需求,而且它的及时性也很有吸引力。因此,社交媒体立即拥有大量受众。于是,越来越多的优质文章出现在自媒体平台上,各位小伙伴都有采集自媒体文章的需求,以下是今日头条采集比如给大家介绍一下自媒体文章怎么用这篇文章介绍一下优采云7.0 采集自媒体< @文章 采集 方法就是今日头条的方法。采集网站:使用功能点:Ajax滚动加载设置列表内容提取步骤:;创建采集任务1)进入主界面选择,选择“自定义模式”云采集服务平台自媒体文章采集步骤2)将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤3)保存URL后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,这是今日头条最新发布的热点新闻。自媒体文章采集 @采集网站:使用功能点:Ajax滚动加载设置列表内容提取步骤:;创建采集任务1)进入主界面选择,选择“自定义模式”云采集服务平台自媒体文章采集步骤2)将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤3)保存URL后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,这是今日头条最新发布的热点新闻。自媒体文章采集 @采集网站:使用功能点:Ajax滚动加载设置列表内容提取步骤:;创建采集任务1)进入主界面选择,选择“自定义模式”云采集服务平台自媒体文章采集步骤2)将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤3)保存URL后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,这是今日头条最新发布的热点新闻。自媒体文章采集 创建采集任务1)进入主界面选择,选择“自定义模式”云采集服务平台自媒体文章采集步骤2)将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤3)保存URL后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,这是今日头条最新发布的热点新闻。自媒体文章采集 创建采集任务1)进入主界面选择,选择“自定义模式”云采集服务平台自媒体文章采集步骤2)将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤3)保存URL后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,这是今日头条最新发布的热点新闻。自媒体文章采集 将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤< @3)保存网址后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,也就是今日头条最新发布的热点新闻。自媒体文章采集 将上述网址的网址复制粘贴到网站的输入框中,点击“保存网址” 云采集服务平台自媒体文章采集步骤< @3)保存网址后,会在优采云采集器中打开页面,红色方块框中的信息就是要呈现的内容采集,也就是今日头条最新发布的热点新闻。自媒体文章采集

云采集服务平台自媒体文章采集Step Step 3:采集新闻内容创作数据提取列表1)如图,移动鼠标选中评论 右击列表框,框背景色变为绿色,然后点击“选择子元素” Cloud采集Service Platform自媒体文章采集Steps 注意:点击右上角的“Process”按钮会显示一个可视化的流程图。2)然后点击“全选”,将页面中需要采集的信息添加到列表云采集服务平台自媒体文章采集步骤说明:提示框中的字段会有一个“X”标志,点击删除该字段。自媒体文章采集

2)采集完成后选择合适的导出方式,将采集好的数据导出到云端采集服务平台自媒体文章采集Step 12 相关采集教程百度搜索结果采集新浪微博数据采集搜狗微信文章采集云采集服务平台70万用户选定的网页数据采集器。1、简单易用,任何人都可以使用:无需技术背景,只需了解互联网采集。全程可视化流程,点击鼠标完成操作,分分钟快速上手。2、功能强大,任意网站可选:用于点击、登录、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据,所有这些都可以通过简单的设置采集进行设置。3、云采集,你也可以关机。配置采集任务后,可以将其关闭,并可以在云端执行任务。庞大的云采集集群24*7不间断运行,无需担心IP阻塞和网络中断。4、可按需选择功能免费增值服务。免费版具有满足用户基本采集需求的所有功能。同时设置一些增值服务(如私有云),满足高端付费企业用户的需求。它可以关闭,任务可以在云端执行。庞大的云采集集群24*7不间断运行,无需担心IP阻塞和网络中断。4、可按需选择功能免费增值服务。免费版具有满足用户基本采集需求的所有功能。同时设置一些增值服务(如私有云),满足高端付费企业用户的需求。它可以关闭,任务可以在云端执行。庞大的云采集集群24*7不间断运行,无需担心IP阻塞和网络中断。4、可按需选择功能免费增值服务。免费版具有满足用户基本采集需求的所有功能。同时设置一些增值服务(如私有云),满足高端付费企业用户的需求。

今日头条文章采集软件(今日头条网站如何使用python爬虫抓取头条上面的新闻链接 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 224 次浏览 • 2022-01-23 12:31

)

今日头条爬虫实战文章前言

本篇博客主要记录如何使用python爬虫爬取今日头条上的新闻链接,然后跟随新闻链接爬取新闻的文字信息,以及新闻的热点信息,即评论数转发和喜欢。

一、如何获取请求url

先打开今日头条网站,注意选择左边的热点选项而不是推荐选项,即最后一个网址的后缀应该是news_hot

然后在当前页面按ctrl+shift+i进入浏览器开发者模式,右上角选择network,如下:

找到如下XHR文件,即中间有category=news_hot的XHR文件,前缀在URL中。![xhr]()

验证,点击预览可以看到所有新闻存储的数据都是以json格式存储的,如下:

查看每条新闻的内容:

这里的参数很多,包括媒体和图片的具体参数,新闻的标题和摘要,新闻来源的url等等,所以我们可以得到新闻的各种参数,方便爬取未来还有更多的事情。

二、爬虫测试

这时候,我们其实可以爬取了。今日头条的json文件不断更新。让我们尝试使用最简单的请求来爬取数据中的文件。

我们首先得到 User-agent 和 cookies

从刚刚打开的 XHR 文件的标题中:

如下所示

拿到后,用最简单的请求爬取:

考试时间为2020年12月10日

1import requests

2 #请求头的书写

3 headers = {

4 'User-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36',

5 'Cookie': 'csrftoken=a1cec75edb840d9c30e91b908b6df006; tt_webid=6903701895266567693; ttcid=de9284562a3d43158bbcf20f427c76bf38; s_v_web_id=verify_kifci8q5_95283jqK_hVnJ_46JY_BWm0_qh2CKMpqyzNp; tt_webid=6903701895266567693; passport_csrf_token=1360da074931584e4d0f4b71d11ecafe; sid_guard=888954813cb61b04ed109f48e8113b56%7C1607393426%7C5184000%7CSat%2C+06-Feb-2021+02%3A10%3A26+GMT; uid_tt=132acd819771d24afff611bdd48dc359; uid_tt_ss=132acd819771d24afff611bdd48dc359; sid_tt=888954813cb61b04ed109f48e8113b56; sessionid=888954813cb61b04ed109f48e8113b56; sessionid_ss=888954813cb61b04ed109f48e8113b56; tt_anti_token=LjrRoQn9d-fe7a8dbda23884fb006dfd76a297fa069a5ef454622aeb4f2994ae7dfe98ac87; __ac_signature=_02B4Z6wo00f017hqegwAAIBDAKwEUeNa15-4bn6AALHgKC7xunrfsuW0d0EgNAvNrli5JTxbZsoDbHSXIYivhqr4RNY5hZqu5s5PdidP7NkmcwuLCUaSrFmYbBzGkUxLlEUPzgL3ukXRVxfTc5; MONITOR_WEB_ID=5f72b98e-ffdf-406a-86be-15dee611591c; tt_scid=wHyPfUtWjE4zJRDRxq.8YEF2HX25EeVt8-bID9j3Txg3rI66rHH9D7xV9JXAMqKPdf64',

6 }

7 r = requests.get(url='https://www.toutiao.com/api/pc ... 27%3B,headers=headers)

8 # 最基本的GET请求

9 print(r.status_code)

10 #输出请求状态码,200代表请求响应

11 print(r.text)

12 #这时输出的json文件是加密的

13 data = json.loads(r.text)

14 #使用json动态加载

15 print(data['data'])

16 #json文件访问

17 print(len(data['data']))

18 #新闻长度是12

19

20

输出就是我们刚才看到的数据文件中新闻的json文件:

这样我们就可以得到一个时间段头条的12条新闻的一些参数,我们可以建立一些列表来保存它们。

三、不停机爬虫

至于如何不断爬取更多的新闻,我们需要分析一下请求url是如何产生的。请参阅下表。表是去年的。当前的url组成可能发生了变化,但是只要我们能找到请求url的组成,也就是你可以不断爬取今日头条网站加载的json文件,挖掘出新闻信息,因为我没有搞了这么久,先写下去年的经验供大家参考,然后具体细节和今年的头条改了反爬虫机制,所以大家需要在这块下点功夫,然后就可以了得以实现。爬虫其实很简单。上面的简单请求是,你可以简单地先尝试一下,然后继续进行下一部分。

比较参数说明:

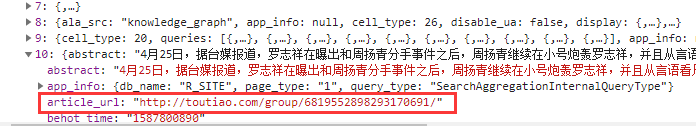

max_behot_time是从获取的json数据中获取的,具体数据如下截图所示:

到目前为止,我们只获得了爬虫的起始url。在后续的爬虫中,我们需要根据上面的参数表获取新闻的url,从而对新闻进行爬取。

继续上面的参数,python 得到 as 和 cp 值:

至于这两个值,去年爬的时候需要用到,可以在csdn找到相关博客了解如何获取as和cp值。至于硒和飞溅的方法,今年都失败了,今日头条升级了反爬措施。, 有针对性的封禁了大部分webdrivers,常用的已经不行了。现在前硬柱面sig参数好像不行。但是既然我们可以通过request方式访问json里面的数据,(上面简单的测试是在20201210)做的,所以应该可以直接获取url,相信你可以给!详情请参考博文破解标题url参数

去年我们只是随机发现了一个代码:

1def get_as_cp(): # 该函数主要是为了获取as和cp参数,程序参考今日头条中的加密js文件:home_4abea46.js

2 zz = {}

3 now = round(time.time())

4 print(now) # 获取当前计算机时间

5 e = hex(int(now)).upper()[2:] #hex()转换一个整数对象为16进制的字符串表示

6 print('e:', e)

7 a = hashlib.md5() #hashlib.md5().hexdigest()创建hash对象并返回16进制结果

8 print('a:', a)

9 a.update(str(int(now)).encode('utf-8'))

10 i = a.hexdigest().upper()

11 print('i:', i)

12 if len(e)!=8:

13 zz = {'as':'479BB4B7254C150',

14 'cp':'7E0AC8874BB0985'}

15 return zz

16 n = i[:5]

17 a = i[-5:]

18 r = ''

19 s = ''

20 for i in range(5):

21 s= s+n[i]+e[i]

22 for j in range(5):

23 r = r+e[j+3]+a[j]

24 zz ={

25 'as':'A1'+s+e[-3:],

26 'cp':e[0:3]+r+'E1'

27 }

28 print('zz:', zz)

29 return zz

30

31

这样就形成了一个完整的链接。还有一点要提的是,去掉_signature参数也可以得到json数据,这样请求的链接就完成了;完整的代码附在下面:

这段代码其实是有参考价值的。只要能找到今年头条url的相关参数,就可以继续进步。

其中,只要弄清楚今日头条的url构成,基本任务就成功了,加油!

1import requests

2import json

3from openpyxl import Workbook

4import time

5import hashlib

6import os

7import datetime

8 #可能不一样

9start_url = 'https://www.toutiao.com/api/pc ... 27%3B

10url = 'https://www.toutiao.com'

11

12headers={

13 'user-agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36'

14}

15cookies = {''} # 此处cookies可从浏览器中查找,为了避免被头条禁止爬虫

16

17max_behot_time = '0' # 链接参数

18title = [] # 存储新闻标题

19source_url = [] # 存储新闻的链接

20s_url = [] # 存储新闻的完整链接

21source = [] # 存储发布新闻的公众号

22media_url = {} # 存储公众号的完整链接

23

24

25def get_as_cp(): # 该函数主要是为了获取as和cp参数,程序参考今日头条中的加密js文件:home_4abea46.js

26 zz = {}

27 now = round(time.time())

28 print(now) # 获取当前计算机时间

29 e = hex(int(now)).upper()[2:] #hex()转换一个整数对象为16进制的字符串表示

30 print('e:', e)

31 a = hashlib.md5() #hashlib.md5().hexdigest()创建hash对象并返回16进制结果

32 print('a:', a)

33 a.update(str(int(now)).encode('utf-8'))

34 i = a.hexdigest().upper()

35 print('i:', i)

36 if len(e)!=8:

37 zz = {'as':'479BB4B7254C150',

38 'cp':'7E0AC8874BB0985'}

39 return zz

40 n = i[:5]

41 a = i[-5:]

42 r = ''

43 s = ''

44 for i in range(5):

45 s= s+n[i]+e[i]

46 for j in range(5):

47 r = r+e[j+3]+a[j]

48 zz ={

49 'as':'A1'+s+e[-3:],

50 'cp':e[0:3]+r+'E1'

51 }

52 print('zz:', zz)

53 return zz

54

55

56def getdata(url, headers, cookies): # 解析网页函数

57 r = requests.get(url, headers=headers, cookies=cookies)

58 print(url)

59 data = json.loads(r.text)

60 return data

61

62

63def savedata(title, s_url, source, media_url): # 存储数据到文件

64 # 存储数据到xlxs文件

65 wb = Workbook()

66 if not os.path.isdir(os.getcwd()+'/result'): # 判断文件夹是否存在

67 os.makedirs(os.getcwd()+'/result') # 新建存储文件夹

68 filename = os.getcwd()+'/result/result-'+datetime.datetime.now().strftime('%Y-%m-%d-%H-%m')+'.xlsx' # 新建存储结果的excel文件

69 ws = wb.active

70 ws.title = 'data' # 更改工作表的标题

71 ws['A1'] = '标题' # 对表格加入标题

72 ws['B1'] = '新闻链接'

73 ws['C1'] = '头条号'

74 ws['D1'] = '头条号链接'

75 for row in range(2, len(title)+2): # 将数据写入表格

76 _= ws.cell(column=1, row=row, value=title[row-2])

77 _= ws.cell(column=2, row=row, value=s_url[row-2])

78 _= ws.cell(column=3, row=row, value=source[row-2])

79 _= ws.cell(column=4, row=row, value=media_url[source[row-2]])

80

81 wb.save(filename=filename) # 保存文件

82

83

84

85def main(max_behot_time, title, source_url, s_url, source, media_url): # 主函数

86 for i in range(3): # 此处的数字类似于你刷新新闻的次数,正常情况下刷新一次会出现10条新闻,但夜存在少于10条的情况;所以最后的结果并不一定是10的倍数

87 ##--------------------------------------------

88 #这一部分就是url的组成部分肯定和今年不一样了,然后获取到的json文件的处理后面基本不难,就是分离出相应的参数

89 ascp = get_as_cp() # 获取as和cp参数的函数

90 demo = getdata(start_url+max_behot_time+'&max_behot_time_tmp='+max_behot_time+'&tadrequire=true&as='+ascp['as']+'&cp='+ascp['cp'], headers, cookies)

91 ##------------------------------------------

92 print(demo)

93 # time.sleep(1)

94 for j in range(len(demo['data'])):

95 # print(demo['data'][j]['title'])

96 if demo['data'][j]['title'] not in title:

97 title.append(demo['data'][j]['title']) # 获取新闻标题

98 source_url.append(demo['data'][j]['source_url']) # 获取新闻链接

99 source.append(demo['data'][j]['source']) # 获取发布新闻的公众号

100 if demo['data'][j]['source'] not in media_url:

101 media_url[demo['data'][j]['source']] = url+demo['data'][j]['media_url'] # 获取公众号链接

102 print(max_behot_time)

103 max_behot_time = str(demo['next']['max_behot_time']) # 获取下一个链接的max_behot_time参数的值

104 for index in range(len(title)):

105 print('标题:', title[index])

106 if 'https' not in source_url[index]:

107 s_url.append(url+source_url[index])

108 print('新闻链接:', url+source_url[index])

109 else:

110 print('新闻链接:', source_url[index])

111 s_url.append(source_url[index])

112 # print('源链接:', url+source_url[index])

113 print('头条号:', source[index])

114 print(len(title)) # 获取的新闻数量

115

116if __name__ == '__main__':

117 main(max_behot_time, title, source_url, s_url, source, media_url)

118 savedata(title, s_url, source, media_url)

119

120 查看全部

今日头条文章采集软件(今日头条网站如何使用python爬虫抓取头条上面的新闻链接

)

今日头条爬虫实战文章前言

本篇博客主要记录如何使用python爬虫爬取今日头条上的新闻链接,然后跟随新闻链接爬取新闻的文字信息,以及新闻的热点信息,即评论数转发和喜欢。

一、如何获取请求url

先打开今日头条网站,注意选择左边的热点选项而不是推荐选项,即最后一个网址的后缀应该是news_hot

然后在当前页面按ctrl+shift+i进入浏览器开发者模式,右上角选择network,如下:

找到如下XHR文件,即中间有category=news_hot的XHR文件,前缀在URL中。![xhr]()

验证,点击预览可以看到所有新闻存储的数据都是以json格式存储的,如下:

查看每条新闻的内容:

这里的参数很多,包括媒体和图片的具体参数,新闻的标题和摘要,新闻来源的url等等,所以我们可以得到新闻的各种参数,方便爬取未来还有更多的事情。

二、爬虫测试

这时候,我们其实可以爬取了。今日头条的json文件不断更新。让我们尝试使用最简单的请求来爬取数据中的文件。

我们首先得到 User-agent 和 cookies

从刚刚打开的 XHR 文件的标题中:

如下所示

拿到后,用最简单的请求爬取:

考试时间为2020年12月10日

1import requests

2 #请求头的书写

3 headers = {

4 'User-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36',

5 'Cookie': 'csrftoken=a1cec75edb840d9c30e91b908b6df006; tt_webid=6903701895266567693; ttcid=de9284562a3d43158bbcf20f427c76bf38; s_v_web_id=verify_kifci8q5_95283jqK_hVnJ_46JY_BWm0_qh2CKMpqyzNp; tt_webid=6903701895266567693; passport_csrf_token=1360da074931584e4d0f4b71d11ecafe; sid_guard=888954813cb61b04ed109f48e8113b56%7C1607393426%7C5184000%7CSat%2C+06-Feb-2021+02%3A10%3A26+GMT; uid_tt=132acd819771d24afff611bdd48dc359; uid_tt_ss=132acd819771d24afff611bdd48dc359; sid_tt=888954813cb61b04ed109f48e8113b56; sessionid=888954813cb61b04ed109f48e8113b56; sessionid_ss=888954813cb61b04ed109f48e8113b56; tt_anti_token=LjrRoQn9d-fe7a8dbda23884fb006dfd76a297fa069a5ef454622aeb4f2994ae7dfe98ac87; __ac_signature=_02B4Z6wo00f017hqegwAAIBDAKwEUeNa15-4bn6AALHgKC7xunrfsuW0d0EgNAvNrli5JTxbZsoDbHSXIYivhqr4RNY5hZqu5s5PdidP7NkmcwuLCUaSrFmYbBzGkUxLlEUPzgL3ukXRVxfTc5; MONITOR_WEB_ID=5f72b98e-ffdf-406a-86be-15dee611591c; tt_scid=wHyPfUtWjE4zJRDRxq.8YEF2HX25EeVt8-bID9j3Txg3rI66rHH9D7xV9JXAMqKPdf64',

6 }

7 r = requests.get(url='https://www.toutiao.com/api/pc ... 27%3B,headers=headers)

8 # 最基本的GET请求

9 print(r.status_code)

10 #输出请求状态码,200代表请求响应

11 print(r.text)

12 #这时输出的json文件是加密的

13 data = json.loads(r.text)

14 #使用json动态加载

15 print(data['data'])

16 #json文件访问

17 print(len(data['data']))

18 #新闻长度是12

19

20

输出就是我们刚才看到的数据文件中新闻的json文件:

这样我们就可以得到一个时间段头条的12条新闻的一些参数,我们可以建立一些列表来保存它们。

三、不停机爬虫

至于如何不断爬取更多的新闻,我们需要分析一下请求url是如何产生的。请参阅下表。表是去年的。当前的url组成可能发生了变化,但是只要我们能找到请求url的组成,也就是你可以不断爬取今日头条网站加载的json文件,挖掘出新闻信息,因为我没有搞了这么久,先写下去年的经验供大家参考,然后具体细节和今年的头条改了反爬虫机制,所以大家需要在这块下点功夫,然后就可以了得以实现。爬虫其实很简单。上面的简单请求是,你可以简单地先尝试一下,然后继续进行下一部分。

比较参数说明:

max_behot_time是从获取的json数据中获取的,具体数据如下截图所示:

到目前为止,我们只获得了爬虫的起始url。在后续的爬虫中,我们需要根据上面的参数表获取新闻的url,从而对新闻进行爬取。

继续上面的参数,python 得到 as 和 cp 值:

至于这两个值,去年爬的时候需要用到,可以在csdn找到相关博客了解如何获取as和cp值。至于硒和飞溅的方法,今年都失败了,今日头条升级了反爬措施。, 有针对性的封禁了大部分webdrivers,常用的已经不行了。现在前硬柱面sig参数好像不行。但是既然我们可以通过request方式访问json里面的数据,(上面简单的测试是在20201210)做的,所以应该可以直接获取url,相信你可以给!详情请参考博文破解标题url参数

去年我们只是随机发现了一个代码:

1def get_as_cp(): # 该函数主要是为了获取as和cp参数,程序参考今日头条中的加密js文件:home_4abea46.js

2 zz = {}

3 now = round(time.time())

4 print(now) # 获取当前计算机时间

5 e = hex(int(now)).upper()[2:] #hex()转换一个整数对象为16进制的字符串表示

6 print('e:', e)

7 a = hashlib.md5() #hashlib.md5().hexdigest()创建hash对象并返回16进制结果

8 print('a:', a)

9 a.update(str(int(now)).encode('utf-8'))

10 i = a.hexdigest().upper()

11 print('i:', i)

12 if len(e)!=8:

13 zz = {'as':'479BB4B7254C150',

14 'cp':'7E0AC8874BB0985'}

15 return zz

16 n = i[:5]

17 a = i[-5:]

18 r = ''

19 s = ''

20 for i in range(5):

21 s= s+n[i]+e[i]

22 for j in range(5):

23 r = r+e[j+3]+a[j]

24 zz ={

25 'as':'A1'+s+e[-3:],

26 'cp':e[0:3]+r+'E1'

27 }

28 print('zz:', zz)

29 return zz

30

31

这样就形成了一个完整的链接。还有一点要提的是,去掉_signature参数也可以得到json数据,这样请求的链接就完成了;完整的代码附在下面:

这段代码其实是有参考价值的。只要能找到今年头条url的相关参数,就可以继续进步。

其中,只要弄清楚今日头条的url构成,基本任务就成功了,加油!

1import requests

2import json

3from openpyxl import Workbook

4import time

5import hashlib

6import os

7import datetime

8 #可能不一样

9start_url = 'https://www.toutiao.com/api/pc ... 27%3B

10url = 'https://www.toutiao.com'

11

12headers={

13 'user-agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36'

14}

15cookies = {''} # 此处cookies可从浏览器中查找,为了避免被头条禁止爬虫

16

17max_behot_time = '0' # 链接参数

18title = [] # 存储新闻标题

19source_url = [] # 存储新闻的链接

20s_url = [] # 存储新闻的完整链接

21source = [] # 存储发布新闻的公众号

22media_url = {} # 存储公众号的完整链接

23

24

25def get_as_cp(): # 该函数主要是为了获取as和cp参数,程序参考今日头条中的加密js文件:home_4abea46.js

26 zz = {}

27 now = round(time.time())

28 print(now) # 获取当前计算机时间

29 e = hex(int(now)).upper()[2:] #hex()转换一个整数对象为16进制的字符串表示

30 print('e:', e)

31 a = hashlib.md5() #hashlib.md5().hexdigest()创建hash对象并返回16进制结果

32 print('a:', a)

33 a.update(str(int(now)).encode('utf-8'))

34 i = a.hexdigest().upper()

35 print('i:', i)

36 if len(e)!=8:

37 zz = {'as':'479BB4B7254C150',

38 'cp':'7E0AC8874BB0985'}

39 return zz

40 n = i[:5]

41 a = i[-5:]

42 r = ''

43 s = ''

44 for i in range(5):

45 s= s+n[i]+e[i]

46 for j in range(5):

47 r = r+e[j+3]+a[j]

48 zz ={

49 'as':'A1'+s+e[-3:],

50 'cp':e[0:3]+r+'E1'

51 }

52 print('zz:', zz)

53 return zz

54

55

56def getdata(url, headers, cookies): # 解析网页函数

57 r = requests.get(url, headers=headers, cookies=cookies)

58 print(url)

59 data = json.loads(r.text)

60 return data

61

62

63def savedata(title, s_url, source, media_url): # 存储数据到文件

64 # 存储数据到xlxs文件

65 wb = Workbook()

66 if not os.path.isdir(os.getcwd()+'/result'): # 判断文件夹是否存在

67 os.makedirs(os.getcwd()+'/result') # 新建存储文件夹

68 filename = os.getcwd()+'/result/result-'+datetime.datetime.now().strftime('%Y-%m-%d-%H-%m')+'.xlsx' # 新建存储结果的excel文件

69 ws = wb.active

70 ws.title = 'data' # 更改工作表的标题

71 ws['A1'] = '标题' # 对表格加入标题

72 ws['B1'] = '新闻链接'

73 ws['C1'] = '头条号'

74 ws['D1'] = '头条号链接'

75 for row in range(2, len(title)+2): # 将数据写入表格

76 _= ws.cell(column=1, row=row, value=title[row-2])

77 _= ws.cell(column=2, row=row, value=s_url[row-2])

78 _= ws.cell(column=3, row=row, value=source[row-2])

79 _= ws.cell(column=4, row=row, value=media_url[source[row-2]])

80

81 wb.save(filename=filename) # 保存文件

82

83

84

85def main(max_behot_time, title, source_url, s_url, source, media_url): # 主函数

86 for i in range(3): # 此处的数字类似于你刷新新闻的次数,正常情况下刷新一次会出现10条新闻,但夜存在少于10条的情况;所以最后的结果并不一定是10的倍数

87 ##--------------------------------------------

88 #这一部分就是url的组成部分肯定和今年不一样了,然后获取到的json文件的处理后面基本不难,就是分离出相应的参数

89 ascp = get_as_cp() # 获取as和cp参数的函数

90 demo = getdata(start_url+max_behot_time+'&max_behot_time_tmp='+max_behot_time+'&tadrequire=true&as='+ascp['as']+'&cp='+ascp['cp'], headers, cookies)

91 ##------------------------------------------

92 print(demo)

93 # time.sleep(1)

94 for j in range(len(demo['data'])):

95 # print(demo['data'][j]['title'])

96 if demo['data'][j]['title'] not in title:

97 title.append(demo['data'][j]['title']) # 获取新闻标题

98 source_url.append(demo['data'][j]['source_url']) # 获取新闻链接

99 source.append(demo['data'][j]['source']) # 获取发布新闻的公众号

100 if demo['data'][j]['source'] not in media_url:

101 media_url[demo['data'][j]['source']] = url+demo['data'][j]['media_url'] # 获取公众号链接

102 print(max_behot_time)

103 max_behot_time = str(demo['next']['max_behot_time']) # 获取下一个链接的max_behot_time参数的值

104 for index in range(len(title)):

105 print('标题:', title[index])

106 if 'https' not in source_url[index]:

107 s_url.append(url+source_url[index])

108 print('新闻链接:', url+source_url[index])

109 else:

110 print('新闻链接:', source_url[index])

111 s_url.append(source_url[index])

112 # print('源链接:', url+source_url[index])

113 print('头条号:', source[index])

114 print(len(title)) # 获取的新闻数量

115

116if __name__ == '__main__':

117 main(max_behot_time, title, source_url, s_url, source, media_url)

118 savedata(title, s_url, source, media_url)

119

120

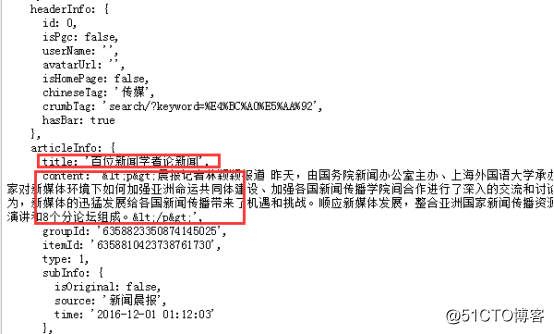

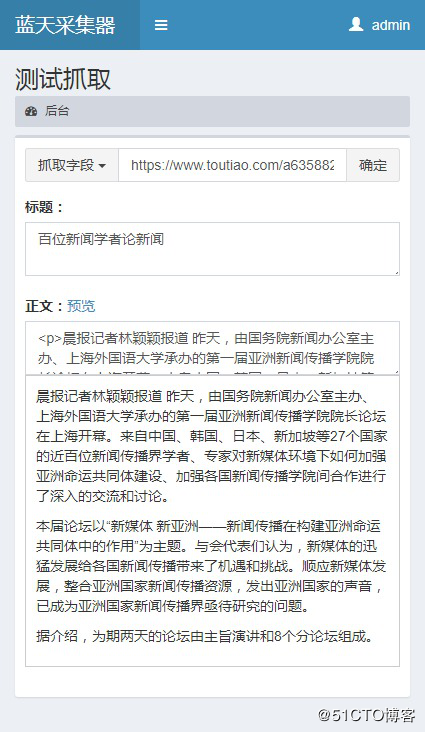

今日头条文章采集软件(今日头条的数据都是ajax加载显示的,需要分析出加载出址)

采集交流 • 优采云 发表了文章 • 0 个评论 • 303 次浏览 • 2022-01-22 08:03

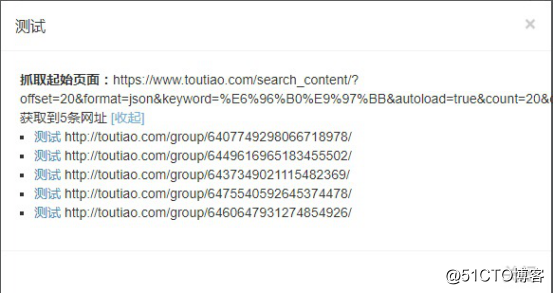

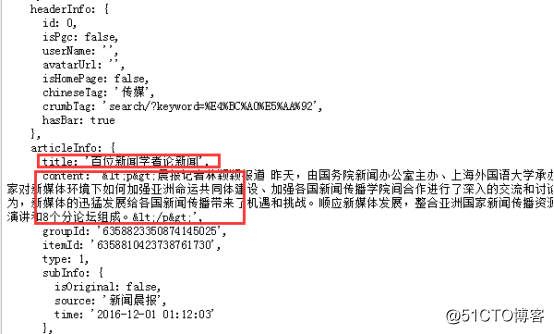

今日头条的数据都是ajax加载显示的。按照正常的url,抓不到数据。有必要分析加载地址。我们以 %E6%96%B0%E9%97%BB 为例对 采集List of 文章

用谷歌浏览器打开链接,右键“Inspect”,在控制台切换到网络点击XHR,这样就可以过滤掉图片、文件等不必要的请求,只看页面内容。

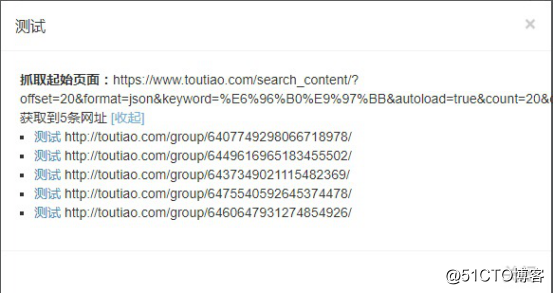

由于页面是ajax加载的,所以拉到页面底部会自动加载更多文章。这时候控制台抓取到的链接就是我们真正需要的列表页链接:

在 优采云采集 中创建一个任务

创建完成后,点击“采集Settings”,在“Start Page URL”中填写上面截取的链接

接下来,匹配内容页面的 URL。标题的文章 URL格式是一个数字/

单击“内容页面 URL”以编写“匹配内容 URL”规则:

这是一个正则规则,意思是把匹配到的URL放到抓包组content1中,然后在下面填写【Content 1】,也就是对应上面的content1,就可以得到内容页链接

可以点击测试查看链接是否爬取成功

爬取成功后就可以开始抓取内容了

点击“获取内容”在字段列表右侧添加默认字段,如title、body等可智能识别,如需准确可自行编辑字段,支持regular、xpath、 json等匹配内容

我们需要获取 文章 的标题和正文。既然是ajax显示,我们需要写规则匹配内容,分析源码:,找到文章的位置

标题规则:articleInfo\s:\s{\stitle:\s'[content1]',

正文规则:content\s:\s'[content1]',\s*groupId

规则必须唯一,否则会匹配到其他内容,将规则添加到字段中,选择规则匹配作为获取方式:

写好规则后,点击保存,点击“测试”看看效果如何

规则正确,抓取正常,抓取的数据也可以发布到cms系统,直接存入数据库,保存为excel文件等,点击下方“发布设置”导航栏,就是这样。今日头条采集的采集就到这里了,大家不妨试试看! 查看全部

今日头条文章采集软件(今日头条的数据都是ajax加载显示的,需要分析出加载出址)

今日头条的数据都是ajax加载显示的。按照正常的url,抓不到数据。有必要分析加载地址。我们以 %E6%96%B0%E9%97%BB 为例对 采集List of 文章

用谷歌浏览器打开链接,右键“Inspect”,在控制台切换到网络点击XHR,这样就可以过滤掉图片、文件等不必要的请求,只看页面内容。

由于页面是ajax加载的,所以拉到页面底部会自动加载更多文章。这时候控制台抓取到的链接就是我们真正需要的列表页链接:

在 优采云采集 中创建一个任务

创建完成后,点击“采集Settings”,在“Start Page URL”中填写上面截取的链接

接下来,匹配内容页面的 URL。标题的文章 URL格式是一个数字/

单击“内容页面 URL”以编写“匹配内容 URL”规则:

这是一个正则规则,意思是把匹配到的URL放到抓包组content1中,然后在下面填写【Content 1】,也就是对应上面的content1,就可以得到内容页链接

可以点击测试查看链接是否爬取成功

爬取成功后就可以开始抓取内容了

点击“获取内容”在字段列表右侧添加默认字段,如title、body等可智能识别,如需准确可自行编辑字段,支持regular、xpath、 json等匹配内容

我们需要获取 文章 的标题和正文。既然是ajax显示,我们需要写规则匹配内容,分析源码:,找到文章的位置

标题规则:articleInfo\s:\s{\stitle:\s'[content1]',

正文规则:content\s:\s'[content1]',\s*groupId

规则必须唯一,否则会匹配到其他内容,将规则添加到字段中,选择规则匹配作为获取方式:

写好规则后,点击保存,点击“测试”看看效果如何

规则正确,抓取正常,抓取的数据也可以发布到cms系统,直接存入数据库,保存为excel文件等,点击下方“发布设置”导航栏,就是这样。今日头条采集的采集就到这里了,大家不妨试试看!

今日头条文章采集软件(非常好用的智能文章生成软件,你错过了吗?!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 571 次浏览 • 2022-01-21 03:01

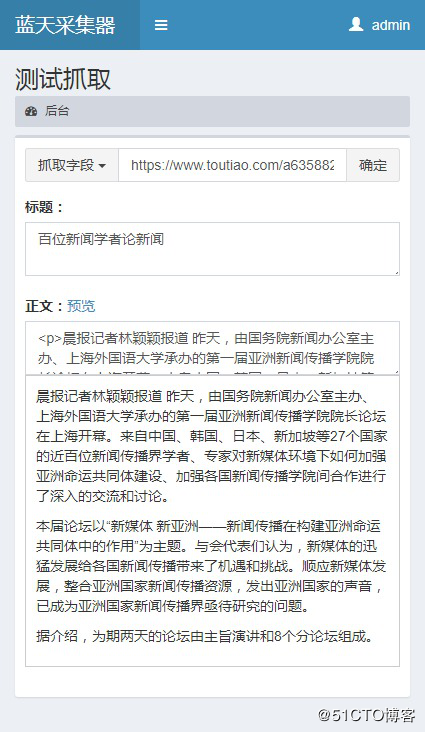

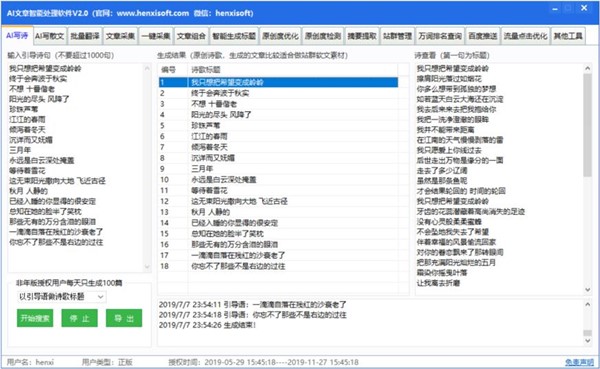

恒喜AI文章生成软件是一款非常好用的智能文章生成软件,可以根据给定的信息文章生成新的关键词、字符、标签等信息@>文章,还支持其他文章进行伪原创处理,需要的朋友不要错过,快来下载吧!

软件说明

Henxi AI文章智能处理软件是一款综合站长工具。软件加入AI技术处理文章内容,实现访问更多原创文章内容功能,如:AI写诗、AI写散文、AI智能生成标题、AI修改< @文章原创度,AI智能组合文章,AI提取摘要,AI处理中英翻译,一键式文章采集,站群管理,织梦站群文章正版,WordPress文章正版,百度排名优化,文章原创度批量检测,万字排名查询、百度推送、熊掌推送、智能图库下载等。

软件功能

1、Intelligence伪原创:利用人工智能中的自然语言处理技术实现文章伪原创的处理。核心功能是“智能伪原创”、“同义词替换伪原创”、“反义词替换伪原创”、“用html代码在文章中随机插入关键词@” >”、“句子打乱重组”等,处理后的文章原创度和收录率均在80%以上。更多功能请下载软件试用。

2、传送门文章采集:一键搜索采集相关传送门网站新闻文章、网站有搜狐、腾讯、新浪、网易.com、今日头条、新兰网、联合早报、光明网、站长网、新文化网等,用户可以进入行业关键词搜索想要的行业文章。该模块的特点是无需编写采集规则,一键操作。友情提示:使用文章时请注明文章出处,尊重原文版权。

3、百度新闻采集:一键搜索各行各业新闻文章,数据来源来自百度新闻搜索引擎,资源丰富,操作灵活,无需写任何采集规则,但缺点是采集的文章不一定完整,但可以满足大部分用户的需求。友情提示:使用文章时请注明文章出处,尊重原文版权。

4、行业文章采集:一键搜索相关行业网站文章,网站行业包括装修家居行业,机械行业,建材行业,家电行业、五金行业、美容行业、育儿行业、金融行业、游戏行业、SEO行业、女性健康行业等有几十家网站网站,资源丰富,本模块可能无法满足所有客户需求,但客户可以提出需求,我们会完善更新模块资源。该模块的特点是无需编写采集规则,一键操作。友情提示:使用文章时请注明文章的出处,

5、写规则采集:自己写采集rules采集,采集rules符合常用的正则表达式,写采集需要了解一些@>rules html代码和正则表达式规则,如果你写过其他商家采集软件的采集规则,那么你一定会写我们软件的采集规则,我们提供编写 采集 @> 规则的文档。我们不为客户编写 采集 规则。如需代写,每条采集规则10元。友情提示:使用文章时请注明文章出处,尊重原文版权。

6、外链文章素材:本模块使用大量行业语料,通过算法随机组合语料产生相关行业文章。本模块文章仅适用于文章对质量要求不高的用户,用于外链推广,本模块具有资源丰富、原创高的特点,缺点是文章 可读性差。用户可以在使用时进行选择。利用。

7、标题量产:有两个功能,一是通过关键词和规则组合批量生产标题,二是通过采集网络大数据获取标题。自动生成的推广精准度高,采集的标题可读性更强,各有优缺点。

8、文章界面发布:通过简单的配置,将生成的文章一键发布到自己的网站。目前支持的网站有,Discuz Portal,Dedecms,Empire Ecms(新闻),PHMcms,淄博cms,PHP168,diypage,phpwind portal .

9、SEO批量查询工具:权重批量查询、排名批量查询、收录批量查询、长尾词挖掘、编码批量转换、文本加解密。

更新内容

1、新增爆文标题AI生成功能

2、修复洗涤过程中的滞后

3、WEB页面在线版入口开发

4、接触人工智能NLP技术 查看全部

今日头条文章采集软件(非常好用的智能文章生成软件,你错过了吗?!)

恒喜AI文章生成软件是一款非常好用的智能文章生成软件,可以根据给定的信息文章生成新的关键词、字符、标签等信息@>文章,还支持其他文章进行伪原创处理,需要的朋友不要错过,快来下载吧!

软件说明

Henxi AI文章智能处理软件是一款综合站长工具。软件加入AI技术处理文章内容,实现访问更多原创文章内容功能,如:AI写诗、AI写散文、AI智能生成标题、AI修改< @文章原创度,AI智能组合文章,AI提取摘要,AI处理中英翻译,一键式文章采集,站群管理,织梦站群文章正版,WordPress文章正版,百度排名优化,文章原创度批量检测,万字排名查询、百度推送、熊掌推送、智能图库下载等。

软件功能

1、Intelligence伪原创:利用人工智能中的自然语言处理技术实现文章伪原创的处理。核心功能是“智能伪原创”、“同义词替换伪原创”、“反义词替换伪原创”、“用html代码在文章中随机插入关键词@” >”、“句子打乱重组”等,处理后的文章原创度和收录率均在80%以上。更多功能请下载软件试用。

2、传送门文章采集:一键搜索采集相关传送门网站新闻文章、网站有搜狐、腾讯、新浪、网易.com、今日头条、新兰网、联合早报、光明网、站长网、新文化网等,用户可以进入行业关键词搜索想要的行业文章。该模块的特点是无需编写采集规则,一键操作。友情提示:使用文章时请注明文章出处,尊重原文版权。

3、百度新闻采集:一键搜索各行各业新闻文章,数据来源来自百度新闻搜索引擎,资源丰富,操作灵活,无需写任何采集规则,但缺点是采集的文章不一定完整,但可以满足大部分用户的需求。友情提示:使用文章时请注明文章出处,尊重原文版权。

4、行业文章采集:一键搜索相关行业网站文章,网站行业包括装修家居行业,机械行业,建材行业,家电行业、五金行业、美容行业、育儿行业、金融行业、游戏行业、SEO行业、女性健康行业等有几十家网站网站,资源丰富,本模块可能无法满足所有客户需求,但客户可以提出需求,我们会完善更新模块资源。该模块的特点是无需编写采集规则,一键操作。友情提示:使用文章时请注明文章的出处,

5、写规则采集:自己写采集rules采集,采集rules符合常用的正则表达式,写采集需要了解一些@>rules html代码和正则表达式规则,如果你写过其他商家采集软件的采集规则,那么你一定会写我们软件的采集规则,我们提供编写 采集 @> 规则的文档。我们不为客户编写 采集 规则。如需代写,每条采集规则10元。友情提示:使用文章时请注明文章出处,尊重原文版权。

6、外链文章素材:本模块使用大量行业语料,通过算法随机组合语料产生相关行业文章。本模块文章仅适用于文章对质量要求不高的用户,用于外链推广,本模块具有资源丰富、原创高的特点,缺点是文章 可读性差。用户可以在使用时进行选择。利用。

7、标题量产:有两个功能,一是通过关键词和规则组合批量生产标题,二是通过采集网络大数据获取标题。自动生成的推广精准度高,采集的标题可读性更强,各有优缺点。

8、文章界面发布:通过简单的配置,将生成的文章一键发布到自己的网站。目前支持的网站有,Discuz Portal,Dedecms,Empire Ecms(新闻),PHMcms,淄博cms,PHP168,diypage,phpwind portal .

9、SEO批量查询工具:权重批量查询、排名批量查询、收录批量查询、长尾词挖掘、编码批量转换、文本加解密。

更新内容

1、新增爆文标题AI生成功能

2、修复洗涤过程中的滞后

3、WEB页面在线版入口开发

4、接触人工智能NLP技术

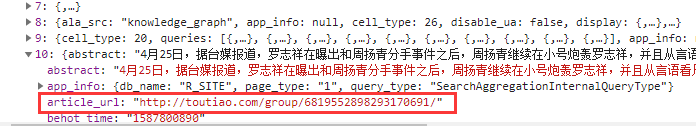

今日头条文章采集软件(爬取思路:请求Ajax数据获取文章url请求文章(组图) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 169 次浏览 • 2022-01-10 01:13

)

1.爬取分析

我们先打开今日头条,搜索“罗志祥”

打开浏览器的开发者工具,红框是我们请求的数据

将搜索界面的滚动条滑动到底部,可以在开发者工具中看到所有请求的数据,加上上一条,一共有7条数据。同时还发现每条数据的offset偏移量是20,所以我们只需要在构造链接请求数据时改变偏移量即可。

点击第一条数据,可以看到请求链接的格式。稍后,我们需要构造参数来生成链接。

为了保证爬虫的稳定性(爬取过程中可能会有验证码),我们需要在请求头中添加如下参数。

现在点击第一条数据,可以看到数据中收录了每个文章的一些数据信息,我们要提取收录文章链接的item_url。

但是我们可以看到,上图中的文章链接并不是今日头条网站,而是今日头条转载的其他网站的文章,以及不同的网站结构@>也不一样,不好解析,所以这里只爬取今天头条网站中的文章。

打开 文章 链接以查看 文章 的内容。

查看网页的源码,可以看到网页是用js渲染的。我们直接使用正则表达式匹配来提取文章的内容。

爬取思路:

请求ajax数据获取文章url请求文章网页正则提取文章主体内容保存文章数据循环爬取2.代码实现

(1) 导入包,构造请求头

import os

import re

import csv

import time

import html

import requests

from urllib.parse import urlencode

headers = {

'cookie': 'tt_webid=6803226732523800077; WEATHER_CITY=%E5%8C%97%E4%BA%AC; tt_webid=6803226732523800077; csrftoken=001c46806c4ddb1c2b0ef69c22890fcf; ttcid=8b695caa90e6433593bc380c6169f17d27; SLARDAR_WEB_ID=5d5ed608-2dda-4d11-b7ed-238121ba5d44; s_v_web_id=verify_k9gguslb_rEU3y1j3_1Egi_4MUX_BRpa_ppngg9dAp1Op; __tasessionId=gjkq6pqc01587870093173; tt_scid=FiyB9z79VVOWXzxX3rQkVUFrbT.kY47exuDy8fdctQueSFw42.wM3KgKWTxahUmG56f2',

'referer': 'https://www.toutiao.com/search ... 39%3B,

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36',

'x-requested-with': 'XMLHttpRequest'

}

(2)请求一条Ajax数据

def get_one_page(offset):

params = {

'aid': '24',

'app_name': 'web_search',

'offset': offset,

'format': 'json',

'keyword': '罗志祥',

'autoload': 'true',

'count': 20,

'en_qc': 1,

'cur_tab': 1,

'from': 'search_tab',

'pd': 'synthesis',

'timestamp': int(time.time())

}

url = 'https://www.toutiao.com/api/se ... 39%3B + urlencode(params)

try:

response = requests.get(url, headers=headers)

if response.status_code == 200:

return response.json()

except requests.ConnectionError:

return None

(3)获取 文章 链接

def get_article_url(json):

if json['count'] != 0: #请求的文章数据不为0

for item in json['data']: #遍历每条文章

if 'article_url' in item: #如果存在文章链接

title = item['title'] #文章标题

publish_time = item['publish_time'] #发布时间戳

datetime = item['datetime'] #发布日期

abstract = item['abstract'] #摘要

article_url = item['article_url'] #文章链接

yield{

'title': title,

'publish_time': publish_time,

'datetime': datetime,

'abstract': abstract,

'article_url': article_url

}

(4)解析文章

def parse_article(article_url):

response = requests.get(article_url, headers=headers) #请求文章

if response.status_code == 200: #响应正常

try:

data = response.content.decode('utf-8')

text = re.findall(r"content:(.+)", data)[0] #正则匹配

text = html.unescape(text) #html转义

text = re.findall(r"'(.+)'", text)[0]

except:

text = None

if text: #替换无效字符

replace_list = [r'\\u003C', r'\\u003E', r'\\u002F', r'p', r'strong', r'p', r'br', r'div (.*?)div']

for replace in replace_list:

text = re.sub(replace, '', text)

return text

(5)保存文章内容

def save_article(content, text):

if not os.path.exists('articles/'):

os.mkdir('articles/')

file_path = 'articles/{0}.{1}'.format(content['title'], 'txt')

if not os.path.exists(file_path): #txt

with open(file_path, 'w', encoding='utf-8') as f:

f.write(text)

with open('articles/articles_table.csv', 'a', encoding='utf-8', newline='') as f:

w = csv.writer(f) #csv

w.writerow([content['title'],content['publish_time'],content['datetime'],content['abstract'],content['article_url'],text])

(6)主函数

def main(offset):

json = get_one_page(offset)

for item in get_article_url(json):

try:

article_url = item['article_url']

text = parse_article(article_url)

if text:

save_article(item, text)

except FileExistsError and OSError:

continue

(7)运行

if __name__ == '__main__':

for i in range(0,7):

main(i * 20)

print('爬取完成')

(8) 爬取结果

3.制作文字云图

分析一下文章主要在说什么。

import csv

import matplotlib.pyplot as plt

import jieba

from wordcloud import WordCloud

#1.读出

text = ''

csv_file = csv.reader(open('articles/articles_table.csv',encoding='utf-8'))

for row in csv_file:

text = text + row[-1]

#2.剪开

cut_text = jieba.cut(text)

stopwords = {'可以','已经','这些','虽然','如果','img','class','handler',

'不是','怎么','甚至','时候','没有','什么','大家','自己'}

cuttext = [i for i in cut_text if i not in stopwords]

#3.以空格拼接起来

result = " ".join(cuttext)

#生成词云

wc = WordCloud(

font_path='C:/Windows/fonts/simhei.ttf', #字体路径

background_color='white', #背景颜色

width=1000,

height=600,

max_font_size=50, #字体大小

min_font_size=10,

mask=plt.imread('bg.jpg'), #背景图片

max_words=1000

)

wc.generate(result)

wc.to_file('wordcloud.png') #图片保存

查看全部

今日头条文章采集软件(爬取思路:请求Ajax数据获取文章url请求文章(组图)

)

1.爬取分析

我们先打开今日头条,搜索“罗志祥”

打开浏览器的开发者工具,红框是我们请求的数据

将搜索界面的滚动条滑动到底部,可以在开发者工具中看到所有请求的数据,加上上一条,一共有7条数据。同时还发现每条数据的offset偏移量是20,所以我们只需要在构造链接请求数据时改变偏移量即可。

点击第一条数据,可以看到请求链接的格式。稍后,我们需要构造参数来生成链接。

为了保证爬虫的稳定性(爬取过程中可能会有验证码),我们需要在请求头中添加如下参数。

现在点击第一条数据,可以看到数据中收录了每个文章的一些数据信息,我们要提取收录文章链接的item_url。

但是我们可以看到,上图中的文章链接并不是今日头条网站,而是今日头条转载的其他网站的文章,以及不同的网站结构@>也不一样,不好解析,所以这里只爬取今天头条网站中的文章。

打开 文章 链接以查看 文章 的内容。

查看网页的源码,可以看到网页是用js渲染的。我们直接使用正则表达式匹配来提取文章的内容。

爬取思路:

请求ajax数据获取文章url请求文章网页正则提取文章主体内容保存文章数据循环爬取2.代码实现

(1) 导入包,构造请求头

import os

import re

import csv

import time

import html

import requests

from urllib.parse import urlencode

headers = {

'cookie': 'tt_webid=6803226732523800077; WEATHER_CITY=%E5%8C%97%E4%BA%AC; tt_webid=6803226732523800077; csrftoken=001c46806c4ddb1c2b0ef69c22890fcf; ttcid=8b695caa90e6433593bc380c6169f17d27; SLARDAR_WEB_ID=5d5ed608-2dda-4d11-b7ed-238121ba5d44; s_v_web_id=verify_k9gguslb_rEU3y1j3_1Egi_4MUX_BRpa_ppngg9dAp1Op; __tasessionId=gjkq6pqc01587870093173; tt_scid=FiyB9z79VVOWXzxX3rQkVUFrbT.kY47exuDy8fdctQueSFw42.wM3KgKWTxahUmG56f2',

'referer': 'https://www.toutiao.com/search ... 39%3B,

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Safari/537.36',

'x-requested-with': 'XMLHttpRequest'

}

(2)请求一条Ajax数据

def get_one_page(offset):

params = {

'aid': '24',

'app_name': 'web_search',

'offset': offset,

'format': 'json',

'keyword': '罗志祥',

'autoload': 'true',

'count': 20,

'en_qc': 1,

'cur_tab': 1,

'from': 'search_tab',

'pd': 'synthesis',

'timestamp': int(time.time())

}

url = 'https://www.toutiao.com/api/se ... 39%3B + urlencode(params)

try:

response = requests.get(url, headers=headers)

if response.status_code == 200:

return response.json()

except requests.ConnectionError:

return None

(3)获取 文章 链接

def get_article_url(json):

if json['count'] != 0: #请求的文章数据不为0

for item in json['data']: #遍历每条文章

if 'article_url' in item: #如果存在文章链接

title = item['title'] #文章标题

publish_time = item['publish_time'] #发布时间戳

datetime = item['datetime'] #发布日期

abstract = item['abstract'] #摘要

article_url = item['article_url'] #文章链接

yield{

'title': title,

'publish_time': publish_time,

'datetime': datetime,

'abstract': abstract,

'article_url': article_url

}

(4)解析文章

def parse_article(article_url):

response = requests.get(article_url, headers=headers) #请求文章

if response.status_code == 200: #响应正常

try:

data = response.content.decode('utf-8')

text = re.findall(r"content:(.+)", data)[0] #正则匹配

text = html.unescape(text) #html转义

text = re.findall(r"'(.+)'", text)[0]

except:

text = None

if text: #替换无效字符

replace_list = [r'\\u003C', r'\\u003E', r'\\u002F', r'p', r'strong', r'p', r'br', r'div (.*?)div']

for replace in replace_list:

text = re.sub(replace, '', text)

return text

(5)保存文章内容

def save_article(content, text):

if not os.path.exists('articles/'):

os.mkdir('articles/')

file_path = 'articles/{0}.{1}'.format(content['title'], 'txt')

if not os.path.exists(file_path): #txt

with open(file_path, 'w', encoding='utf-8') as f:

f.write(text)

with open('articles/articles_table.csv', 'a', encoding='utf-8', newline='') as f:

w = csv.writer(f) #csv

w.writerow([content['title'],content['publish_time'],content['datetime'],content['abstract'],content['article_url'],text])

(6)主函数

def main(offset):

json = get_one_page(offset)

for item in get_article_url(json):

try:

article_url = item['article_url']

text = parse_article(article_url)

if text:

save_article(item, text)

except FileExistsError and OSError:

continue

(7)运行

if __name__ == '__main__':

for i in range(0,7):

main(i * 20)

print('爬取完成')

(8) 爬取结果

3.制作文字云图

分析一下文章主要在说什么。

import csv

import matplotlib.pyplot as plt

import jieba

from wordcloud import WordCloud

#1.读出

text = ''

csv_file = csv.reader(open('articles/articles_table.csv',encoding='utf-8'))

for row in csv_file:

text = text + row[-1]

#2.剪开

cut_text = jieba.cut(text)

stopwords = {'可以','已经','这些','虽然','如果','img','class','handler',

'不是','怎么','甚至','时候','没有','什么','大家','自己'}

cuttext = [i for i in cut_text if i not in stopwords]

#3.以空格拼接起来

result = " ".join(cuttext)

#生成词云

wc = WordCloud(

font_path='C:/Windows/fonts/simhei.ttf', #字体路径

background_color='white', #背景颜色

width=1000,

height=600,

max_font_size=50, #字体大小

min_font_size=10,

mask=plt.imread('bg.jpg'), #背景图片

max_words=1000

)

wc.generate(result)

wc.to_file('wordcloud.png') #图片保存

今日头条文章采集软件(有哪些技巧来提高阅读量呢?阅读量的技巧 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 125 次浏览 • 2022-01-10 00:06

)

无论是今日头条的菜鸟,还是变成常客的老手。他们都非常重视文章的阅读量。看来阅读量是评价我们的文章质量好坏的标准,阅读量能体现我们的创造能力。那么我们有什么技巧可以提高阅读能力呢?

概述

我们知道,阅读头条的数量直接取决于推荐的数量。所以首先,我们应该从推荐的数量上改进。推荐水平直接决定阅读水平。

推荐量的提高可以从以下几个方面进行改进:

增加推荐的技巧

高级 原创。

独立完成的高质量创作。并且首发于头条平台,最重要的是今天的头条收录中没有类似的文章。不仅今日头条看好,百度的收录也会更喜欢。一般只要是原创的文章,有一定正能量或真实性的文章,推荐量不会少。

“绿色”的称号。

一个好的标题是成功的一半,当然,不要只做标题派对。更重要的是,文字标题要一致,好马配好鞍,好内容配好标题。这会引起别人的兴趣。

插图。

封面图片是映射 文章 吸引力的另一个关键因素。尤其是封面图,当然文章有图片的内容也很重要。

异地阅读。

通过分享到其他平台增加阅读量,如QQ、微信、QQ空间、朋友圈、微博等站外平台。

场是垂直的。

根据您注册的字段选择相关字段的文章。保证场地的垂直度,从而获得高推荐。

擦热点。

蹭热点关键词也是一种获得高推荐的技巧。当然,也不是随便擦,擦得不好会适得其反。

查看全部

今日头条文章采集软件(有哪些技巧来提高阅读量呢?阅读量的技巧

)

无论是今日头条的菜鸟,还是变成常客的老手。他们都非常重视文章的阅读量。看来阅读量是评价我们的文章质量好坏的标准,阅读量能体现我们的创造能力。那么我们有什么技巧可以提高阅读能力呢?

概述

我们知道,阅读头条的数量直接取决于推荐的数量。所以首先,我们应该从推荐的数量上改进。推荐水平直接决定阅读水平。

推荐量的提高可以从以下几个方面进行改进:

增加推荐的技巧

高级 原创。

独立完成的高质量创作。并且首发于头条平台,最重要的是今天的头条收录中没有类似的文章。不仅今日头条看好,百度的收录也会更喜欢。一般只要是原创的文章,有一定正能量或真实性的文章,推荐量不会少。

“绿色”的称号。

一个好的标题是成功的一半,当然,不要只做标题派对。更重要的是,文字标题要一致,好马配好鞍,好内容配好标题。这会引起别人的兴趣。

插图。

封面图片是映射 文章 吸引力的另一个关键因素。尤其是封面图,当然文章有图片的内容也很重要。

异地阅读。

通过分享到其他平台增加阅读量,如QQ、微信、QQ空间、朋友圈、微博等站外平台。

场是垂直的。

根据您注册的字段选择相关字段的文章。保证场地的垂直度,从而获得高推荐。

擦热点。

蹭热点关键词也是一种获得高推荐的技巧。当然,也不是随便擦,擦得不好会适得其反。

今日头条文章采集软件(今日头条文章采集软件,可以采集微头条(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2022-01-09 20:05

今日头条文章采集软件,可以采集今日头条,微头条,百家号,搜狐,网易,企鹅,大鱼,趣头条等等自媒体平台上的文章!采集后的文章,再对文章进行原标题加工,就可以搬运到其他自媒体平台,获取广告分成!自媒体需要营销,获取流量的前提是文章能够获得一定的浏览量,那么怎么获取一篇高点击率的文章,下面小编给大家讲讲怎么实现文章点击率高达6%?下面的实操教程就会分享到一款软件,写好的文章发布出去后,看到的点击率或转发率高于6%的文章都会提示你,将文章转发到微信和qq,并置顶,不浪费时间,以文章作为诱饵,吸引更多的人加好友,最终实现精准引流。

怎么实现文章点击率高达6%?生活技巧、职场指南、情感情趣、漂亮美女、运动健身等等,关键词展示率高都可以试一试!只需将文章采集过来,点击开始采集后,系统就会对文章进行审核,审核完成后,会自动将文章分类,这样可以更加利于文章再其他平台上面获取曝光!系统会根据文章的内容进行类型划分,如果文章内容达不到分类的要求,那么系统自动会将内容分类到相应的类型,而不会无限制的去对内容进行分类!另外,文章本身要写的不要太浮夸,会让用户看了文章之后,感觉花费了很多的时间,打开率非常的低,不如直接直接的在其他平台上面把文章上传直接能够获取到用户的看文率更高!编辑几句花样的语言,也是可以的,但是必须具有说服力,否则没有任何的意义!就像微信头像,必须具有一定的辨识度,不要是文字,不要是花里胡哨的图片,否则用户下次直接去搜索头像的话,是很难发现文章中是有关键词的!引导别人直接去搜索你文章中的关键词实现精准引流的效果会更加明显!总结:第。

一、看点击率,文章点击率高于6%的文章.第

二、首先检查点击率文章,文章标题一定要新颖或者生动有趣.第

三、找自己适合的领域开始写,写标题时,

四、检查哪里写的不好,可以检查以下:开头,一开始定位不清晰!中间,是否有太长的废话?结尾,你想要表达的意思是否表达清楚?显得重复等等。

五、第二篇的收益情况如何?如果情况反差太大,坚决不要重复发布!最后,随着互联网和自媒体的发展,越来越多的个人和企业发现利用自媒体来宣传自己的产品或者品牌。在自媒体平台上进行产品的推广,一来可以拓展产品的展示渠道,在自媒体平台上曝光产品,让客户看到并决定是否去买你的产品,二来可以做一些相关的分享。自媒体的普及,加上各大自媒体平台的发展壮大,很多人想通过自媒体来获取流量和收益,但是怎么做呢?下面是小编给大家提供的一些通。 查看全部

今日头条文章采集软件(今日头条文章采集软件,可以采集微头条(组图))

今日头条文章采集软件,可以采集今日头条,微头条,百家号,搜狐,网易,企鹅,大鱼,趣头条等等自媒体平台上的文章!采集后的文章,再对文章进行原标题加工,就可以搬运到其他自媒体平台,获取广告分成!自媒体需要营销,获取流量的前提是文章能够获得一定的浏览量,那么怎么获取一篇高点击率的文章,下面小编给大家讲讲怎么实现文章点击率高达6%?下面的实操教程就会分享到一款软件,写好的文章发布出去后,看到的点击率或转发率高于6%的文章都会提示你,将文章转发到微信和qq,并置顶,不浪费时间,以文章作为诱饵,吸引更多的人加好友,最终实现精准引流。

怎么实现文章点击率高达6%?生活技巧、职场指南、情感情趣、漂亮美女、运动健身等等,关键词展示率高都可以试一试!只需将文章采集过来,点击开始采集后,系统就会对文章进行审核,审核完成后,会自动将文章分类,这样可以更加利于文章再其他平台上面获取曝光!系统会根据文章的内容进行类型划分,如果文章内容达不到分类的要求,那么系统自动会将内容分类到相应的类型,而不会无限制的去对内容进行分类!另外,文章本身要写的不要太浮夸,会让用户看了文章之后,感觉花费了很多的时间,打开率非常的低,不如直接直接的在其他平台上面把文章上传直接能够获取到用户的看文率更高!编辑几句花样的语言,也是可以的,但是必须具有说服力,否则没有任何的意义!就像微信头像,必须具有一定的辨识度,不要是文字,不要是花里胡哨的图片,否则用户下次直接去搜索头像的话,是很难发现文章中是有关键词的!引导别人直接去搜索你文章中的关键词实现精准引流的效果会更加明显!总结:第。

一、看点击率,文章点击率高于6%的文章.第

二、首先检查点击率文章,文章标题一定要新颖或者生动有趣.第

三、找自己适合的领域开始写,写标题时,

四、检查哪里写的不好,可以检查以下:开头,一开始定位不清晰!中间,是否有太长的废话?结尾,你想要表达的意思是否表达清楚?显得重复等等。

五、第二篇的收益情况如何?如果情况反差太大,坚决不要重复发布!最后,随着互联网和自媒体的发展,越来越多的个人和企业发现利用自媒体来宣传自己的产品或者品牌。在自媒体平台上进行产品的推广,一来可以拓展产品的展示渠道,在自媒体平台上曝光产品,让客户看到并决定是否去买你的产品,二来可以做一些相关的分享。自媒体的普及,加上各大自媒体平台的发展壮大,很多人想通过自媒体来获取流量和收益,但是怎么做呢?下面是小编给大家提供的一些通。

今日头条文章采集软件(今日头条推荐流量图,看起来人也会分享一些推荐)

采集交流 • 优采云 发表了文章 • 0 个评论 • 229 次浏览 • 2022-01-07 10:11

为什么我们在今天的头条上看到很多创作者常说的,不要删除已发布的文章和视频,否则可能会面临当前的限制或不被推荐。大多数人也会分享一些推荐的交通图。看来是有道理的,也是有根据的。下面我谈谈我对这个问题的看法。我会在文末解释一些不太容易理解的技术词汇。

首先这个事情是分内容的,就是看你删的是什么内容。很多人会删除已经播放和阅读过的内容(统称为“消费”),甚至是消费数以万计的内容。此类内容删除后会受到限制,可以从以下两个方面来理解。

1、 有推荐有消费,就是说内容就是用户需要的,标题需要的。你删除它。从侧面看,它表明您将标题变成了不那么“有价值”的内容。

2、 创作者自己理解的原因并不是真正意义上的推荐和消费少,而是内容质量存在一些我们不知道的问题,所谓的说的是“限流”。

说完上面的原因,我们再来看看“推荐量低、消耗低的内容”。如果删除它,删除此类内容的人很多。原因是大家的想法都差不多,“既不是推荐也不是我没看过,在内容管理列表上看着不舒服”,就删了。

如果删除此类内容真的是“推荐消费减少”的原因,我认为可能是以下原因:

所有信息(文章、视频、声音)都有一个“数字指纹”。这个数字指纹可以判断这个信息在一定时间内是否唯一。这与视频和软件的 md5 值相同。用于判断该信息的唯一性和准确性。

那么它的好处就更大了。如果不删除自己的内容,也就是在头条数据库中,可以作为头条来判断其他内容(别人的)是原创还是原创,对于像这样的内容制作平台今日头条,内容越多(即数据量越大),越容易判断“新输出”的内容原创程度如何。

这也是为什么现在有很多“专业洗”的球队,几十个球迷也能赢的原因。他们从历史文件和论文中复制。人工审核和控制太多(复制的内容没有原创参考数据)。请注意,它是复制品,而不是汇编或解释。

历史内容和论文两大内容载体在互联网上一直处于真空状态。你为什么这么说?

一些不在官方历史中的历史文献出奇地罕见,一些是口头叙述的,一些实体书籍很少出现在互联网上。

不用说,论文被主要学术机构控制。即使是在网上发布,也需要注册一个账号才能阅读。其中一些需要充电。此类信息在搜索引擎中通常称为“被阻止”的信息。,很多会出现在一些专业的网站上,反正搜索引擎也抓不到,但是这种信息很有价值。

信息强调稀缺性,越稀缺越有价值。

所以你明白了,为什么在“今日头条不想你删内容”之后你还要删内容?其实不用删,只是对互联网的一点贡献而已。你认为的“垃圾邮件”,经过大数据清洗后,可能会成为更有价值的信息。

专业词解释:

1、 限流:降低某条消息(某账号)的推荐频率和覆盖面,比如只推荐给粉丝。

2、消费:用户观看视频是一种消费,阅读文章是一种消费。一般来说,它是用户阅读和查看内容的次数。

3、md5值:是一种信息(数据)加密算法,相同的信息(字节串)可以加密一次或多次得到相同的加密串(串),用于验证信息是否为原创信息已经改了,反方向,不能通过加密串导出原创信息(除了一些特征词,即ab中不同信息的md5是一样的,概率很小)。

4、搜索引擎:传统意义上的“百度、搜狗、必应、谷歌”等。现在网站上有“头条搜索”和各种应用内搜索,都可以称为搜索引擎。(注:从技术上讲,“今日头条”和“今日头条”不是同一个产品)

5、数字指纹:数字指纹可用于所有数字信息(即数据)。目前还没有统一的协议和规则,各大公司采用的方法也不尽相同。对于搜索引擎,最简单的方法是对原创信息进行去重、去噪、去冗余、去格式、无意义的高频模态粒子(中文),然后用自己的方法生成这个文章的数字索引,有了这个,就可以很好的判断这个文章最早出现在什么地方,是谁发的。

对于视频,同样的道理是根据视频风格、长度、分辨率、码率等对视频进行分类,每隔一定时间截取视频图像进行识别和标记,最后统一生成数字指纹.

音频数据有声纹。这样大家就更容易理解了。通过记录不同段声音的频率、幅度和持续时间,您可以获得数字指纹。

以上只是数字指纹采集的基本思路,实际公司使用的思路比这更复杂,可能通过视频和声音的多个采集特征字节码生成对应的数字指纹。(找张图把1.jpg改成1.txt看看是什么)

因此,你会看到网络抄袭大军在寻找一款神级软件:“视频md5修改器”。传说已经用过了,西瓜视频抖音已经无法识别你移动的视频了。向上。

我只能说你还太年轻。更改视频几秒钟确实可以更改 md5 值。确实是原视频,但真的有那么简单吗?

搜索引擎的收录系统还有一个东西叫“语义识别与判断系统”,就是通过人工智能和大数据的对比,你大概知道这个文章和视频是关于什么的,看您可以了解您的标题帖子中推荐了哪个专栏文章。虽然有时你觉得它可能不准确,识别度不高,但它并不是一个你根本不想做的类别。想想这个。认可度有多高?

算了,就写在这里吧。我想简单说一下为什么不建议大家删除今天标题末尾的内容,但是恐怕很多同学看不懂里面的一些词,而且解释的也很多。我不是大型系统开发专业的,上面说的都是简单粗暴的。专业的学生路过,手下留情。我不想做科普账号。我还是一个旅游账号。 查看全部

今日头条文章采集软件(今日头条推荐流量图,看起来人也会分享一些推荐)

为什么我们在今天的头条上看到很多创作者常说的,不要删除已发布的文章和视频,否则可能会面临当前的限制或不被推荐。大多数人也会分享一些推荐的交通图。看来是有道理的,也是有根据的。下面我谈谈我对这个问题的看法。我会在文末解释一些不太容易理解的技术词汇。

首先这个事情是分内容的,就是看你删的是什么内容。很多人会删除已经播放和阅读过的内容(统称为“消费”),甚至是消费数以万计的内容。此类内容删除后会受到限制,可以从以下两个方面来理解。

1、 有推荐有消费,就是说内容就是用户需要的,标题需要的。你删除它。从侧面看,它表明您将标题变成了不那么“有价值”的内容。

2、 创作者自己理解的原因并不是真正意义上的推荐和消费少,而是内容质量存在一些我们不知道的问题,所谓的说的是“限流”。

说完上面的原因,我们再来看看“推荐量低、消耗低的内容”。如果删除它,删除此类内容的人很多。原因是大家的想法都差不多,“既不是推荐也不是我没看过,在内容管理列表上看着不舒服”,就删了。

如果删除此类内容真的是“推荐消费减少”的原因,我认为可能是以下原因:

所有信息(文章、视频、声音)都有一个“数字指纹”。这个数字指纹可以判断这个信息在一定时间内是否唯一。这与视频和软件的 md5 值相同。用于判断该信息的唯一性和准确性。

那么它的好处就更大了。如果不删除自己的内容,也就是在头条数据库中,可以作为头条来判断其他内容(别人的)是原创还是原创,对于像这样的内容制作平台今日头条,内容越多(即数据量越大),越容易判断“新输出”的内容原创程度如何。

这也是为什么现在有很多“专业洗”的球队,几十个球迷也能赢的原因。他们从历史文件和论文中复制。人工审核和控制太多(复制的内容没有原创参考数据)。请注意,它是复制品,而不是汇编或解释。

历史内容和论文两大内容载体在互联网上一直处于真空状态。你为什么这么说?

一些不在官方历史中的历史文献出奇地罕见,一些是口头叙述的,一些实体书籍很少出现在互联网上。

不用说,论文被主要学术机构控制。即使是在网上发布,也需要注册一个账号才能阅读。其中一些需要充电。此类信息在搜索引擎中通常称为“被阻止”的信息。,很多会出现在一些专业的网站上,反正搜索引擎也抓不到,但是这种信息很有价值。

信息强调稀缺性,越稀缺越有价值。

所以你明白了,为什么在“今日头条不想你删内容”之后你还要删内容?其实不用删,只是对互联网的一点贡献而已。你认为的“垃圾邮件”,经过大数据清洗后,可能会成为更有价值的信息。

专业词解释:

1、 限流:降低某条消息(某账号)的推荐频率和覆盖面,比如只推荐给粉丝。

2、消费:用户观看视频是一种消费,阅读文章是一种消费。一般来说,它是用户阅读和查看内容的次数。

3、md5值:是一种信息(数据)加密算法,相同的信息(字节串)可以加密一次或多次得到相同的加密串(串),用于验证信息是否为原创信息已经改了,反方向,不能通过加密串导出原创信息(除了一些特征词,即ab中不同信息的md5是一样的,概率很小)。

4、搜索引擎:传统意义上的“百度、搜狗、必应、谷歌”等。现在网站上有“头条搜索”和各种应用内搜索,都可以称为搜索引擎。(注:从技术上讲,“今日头条”和“今日头条”不是同一个产品)

5、数字指纹:数字指纹可用于所有数字信息(即数据)。目前还没有统一的协议和规则,各大公司采用的方法也不尽相同。对于搜索引擎,最简单的方法是对原创信息进行去重、去噪、去冗余、去格式、无意义的高频模态粒子(中文),然后用自己的方法生成这个文章的数字索引,有了这个,就可以很好的判断这个文章最早出现在什么地方,是谁发的。

对于视频,同样的道理是根据视频风格、长度、分辨率、码率等对视频进行分类,每隔一定时间截取视频图像进行识别和标记,最后统一生成数字指纹.

音频数据有声纹。这样大家就更容易理解了。通过记录不同段声音的频率、幅度和持续时间,您可以获得数字指纹。

以上只是数字指纹采集的基本思路,实际公司使用的思路比这更复杂,可能通过视频和声音的多个采集特征字节码生成对应的数字指纹。(找张图把1.jpg改成1.txt看看是什么)

因此,你会看到网络抄袭大军在寻找一款神级软件:“视频md5修改器”。传说已经用过了,西瓜视频抖音已经无法识别你移动的视频了。向上。

我只能说你还太年轻。更改视频几秒钟确实可以更改 md5 值。确实是原视频,但真的有那么简单吗?

搜索引擎的收录系统还有一个东西叫“语义识别与判断系统”,就是通过人工智能和大数据的对比,你大概知道这个文章和视频是关于什么的,看您可以了解您的标题帖子中推荐了哪个专栏文章。虽然有时你觉得它可能不准确,识别度不高,但它并不是一个你根本不想做的类别。想想这个。认可度有多高?

算了,就写在这里吧。我想简单说一下为什么不建议大家删除今天标题末尾的内容,但是恐怕很多同学看不懂里面的一些词,而且解释的也很多。我不是大型系统开发专业的,上面说的都是简单粗暴的。专业的学生路过,手下留情。我不想做科普账号。我还是一个旅游账号。

今日头条文章采集软件(实用文档文案大全今日头条爆文采集器使用步骤详解!!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 437 次浏览 • 2022-01-05 04:10

实用文档文案百科今日头条爆文采集器 使用方法 目前有很多人对今日头条采集的需求量很大,比如站长、自媒体运营商、采集今天的头条新闻。爆文的内容在网上,然后通过伪原创或者手动修改,然后发布到自己的网站或者微信公众号,以获得相关流量,以后在各种方式实现。市面上有很多爆文采集器,但是很多采集的设置都不太灵活,及时性也是个问题。这里推荐今日头条爆文采集器,你可以采集最新今日头条文章,自定义灵活采集你想要的数据。最重要的是免费使用它。采集网站:使用功能点:Ajax滚动加载设置列表内容提取步骤1:创建采集任务1)进入主界面选择,选择“自定义模式”实用文案文案百科今日头条爆文采集器 使用步骤1 2) 将上述网址的网址复制粘贴到网站输入框,点击“保存网址”今日头条爆文采集器使用Step 2 实用文档文案百科3) 保存URL后,页面会在优采云采集器中打开,红框信息是这次演示的关键 采集 的内容是今日头条发布的最新热点新闻。今日头条爆文采集器

今日头条爆文采集器使用步骤5实用文案文案百科步骤3:采集新闻内容创作数据提取列表1)如图,移动鼠标选中评论列表框,右击,框的背景颜色会变成绿色,然后点击“选择子元素”今日头条爆文采集器使用步骤6 注意:点击“处理”按钮在右上角显示可视化流程图。2) 然后点击“全选”,将页面上需要采集的信息添加到列表中。实用文档文案大全今日头条爆文采集器 使用步骤7 注意:在提示框中的字段上会出现一个“X”,点击删除该字段。

2)采集完成后选择合适的导出方式将采集好的数据导出到实用文档文案大全今日头条爆文采集器使用第12步相关采集教程:自媒体免费爆文采集微信文章采集网易新闻数据采集方法新浪微博评论数据抓取和< @采集方法快乐书客小说采集 自媒体文章how采集 爆文采集method优采云——网页700,000 个用户选择的数据采集器。实用文档文案书1、操作简单,任何人都可以使用:无需技术背景,即可上网采集。过程完全可视化,点击鼠标即可完成操作,并且您可以在 2 分钟内快速上手。2、功能强大,任何网站都可以:点击、登录、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据,都可以通过简单的设置来设置< @采集。3、云采集,可以关掉。配置完采集任务后,可以关闭,任务可以在云端执行。庞达云采集集群24*7不间断运行,不用担心IP被封,网络中断。4、功能免费+增值服务,可根据需要选择。免费版功能齐全,可以满足用户基本的采集需求。同时, 查看全部

今日头条文章采集软件(实用文档文案大全今日头条爆文采集器使用步骤详解!!)

实用文档文案百科今日头条爆文采集器 使用方法 目前有很多人对今日头条采集的需求量很大,比如站长、自媒体运营商、采集今天的头条新闻。爆文的内容在网上,然后通过伪原创或者手动修改,然后发布到自己的网站或者微信公众号,以获得相关流量,以后在各种方式实现。市面上有很多爆文采集器,但是很多采集的设置都不太灵活,及时性也是个问题。这里推荐今日头条爆文采集器,你可以采集最新今日头条文章,自定义灵活采集你想要的数据。最重要的是免费使用它。采集网站:使用功能点:Ajax滚动加载设置列表内容提取步骤1:创建采集任务1)进入主界面选择,选择“自定义模式”实用文案文案百科今日头条爆文采集器 使用步骤1 2) 将上述网址的网址复制粘贴到网站输入框,点击“保存网址”今日头条爆文采集器使用Step 2 实用文档文案百科3) 保存URL后,页面会在优采云采集器中打开,红框信息是这次演示的关键 采集 的内容是今日头条发布的最新热点新闻。今日头条爆文采集器

今日头条爆文采集器使用步骤5实用文案文案百科步骤3:采集新闻内容创作数据提取列表1)如图,移动鼠标选中评论列表框,右击,框的背景颜色会变成绿色,然后点击“选择子元素”今日头条爆文采集器使用步骤6 注意:点击“处理”按钮在右上角显示可视化流程图。2) 然后点击“全选”,将页面上需要采集的信息添加到列表中。实用文档文案大全今日头条爆文采集器 使用步骤7 注意:在提示框中的字段上会出现一个“X”,点击删除该字段。

2)采集完成后选择合适的导出方式将采集好的数据导出到实用文档文案大全今日头条爆文采集器使用第12步相关采集教程:自媒体免费爆文采集微信文章采集网易新闻数据采集方法新浪微博评论数据抓取和< @采集方法快乐书客小说采集 自媒体文章how采集 爆文采集method优采云——网页700,000 个用户选择的数据采集器。实用文档文案书1、操作简单,任何人都可以使用:无需技术背景,即可上网采集。过程完全可视化,点击鼠标即可完成操作,并且您可以在 2 分钟内快速上手。2、功能强大,任何网站都可以:点击、登录、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据,都可以通过简单的设置来设置< @采集。3、云采集,可以关掉。配置完采集任务后,可以关闭,任务可以在云端执行。庞达云采集集群24*7不间断运行,不用担心IP被封,网络中断。4、功能免费+增值服务,可根据需要选择。免费版功能齐全,可以满足用户基本的采集需求。同时,

今日头条文章采集软件(【易媒助手9大特色功能】+平台支持40+主流新媒体平台)

采集交流 • 优采云 发表了文章 • 0 个评论 • 424 次浏览 • 2022-01-02 20:04

Emedia Assistant:内容投放工具有望获得可喜的广告份额。通常个人、公司选择入驻观看点、全国小视频等10多个热门自媒体平台,如果只同步文章,分发到8个平台需要近20分钟,并且它恰好有更多的长视频。 10个平台大约需要一个小时,需要确保所有上传完成。达到目的后,你会觉得每次同步真的很费时费力,只需要借助易媒体助手的分发软件,轻松将稿件和视频同时上传到30多个平台。上传只需七八分钟,排名不高。

视频图文一键上传结束,我来操作一键发布视频,你聪明,分分钟学会,点击下载视频(上图菜单部分),在为了节省以后的时间,这里是默认的分类设置好的,在本地添加您的视频内容后,在下面的视频内容周围填写标题,介绍和标签。当您填写完毕后,我们只需点击此处发布,就会出现要发布的帐户。选择您要发布的群组。一次性分发内容,比一份一份发布节省太多时间。今日头条视频多账号自动群发工具

舆情数据文章写个大佬,实现10万+的创造,一定要关注热点事件,挖掘可以参考的热点。直接有效的就是看热搜榜的内容,下面自媒体一般人都在用:易媒体助手,一帆千官

【EasyMedia 助手的 9 个功能】

1.40+平台支持:支持40+主流新媒体平台,新平台不断对接

2.1000+账户管理:轻松支持1000+账户管理,全新底层优化设计,自动记忆账户秘密,自动登录,无论多少账户都不怕挑战

3.爆文系统:实时采集热点文章,视频,让你轻松实时热点,打造局部10万+

4.AI智能改写:轻松改写收录,让你推广、关键词覆盖、软文等任务如虎添翼

5.一键分发:一键轻松分发文章、视频、小视频、微动到30+主流平台

6.团队管理:支持创建子账号,实现屏蔽收入、账号密码、员工操作统计等功能

7.原创度数检测:基于3大搜索引擎,一键检测文章原创度数,复查复核工具

8.微信帖子:支持一键发布微信帖子到:微头条、百家新闻、微博等平台

9.数据概览:一键查看平台所有收入、播放、阅读等数据

数据似乎还没有被注意到。事实上,它是一个非常有用的日常数据宝藏网站。这种网站不仅完整,而且有效。帮助我们使视频看起来更好。下面我喜欢用这些强大的工具实时动态微信热点文章,希望对各位编辑有所帮助:搜狗指数今日头条视频多账号自动群发工具

易媒体助手添加媒体账号功能需要通过您的账号完成,所以添加账号并选择您要操作的平台。如果是第一次使用,请用账号和密码登录,不要扫码登录。 自媒体号码。今日头条视频多账号自动群发工具

视频素材与文章的写作要求相同。其他类似的材料也是必不可少的。缺一不可的是,视频内容的整合还是要以其他热门视频为基础。如果你积累了很多内容源,你就可以完成内容。总的来说,它可能是非常高质量的。接下来我就数了几个特别实用的素材站,一定对“受苦编辑”有帮助:youtube、Vidsplay

一键分发视频,接下来我来操作一下如何一键分发视频,首先点击“发送视频”(在软件顶部),为了节省以后的时间,这里先设置默认分类,然后上传。发布视频,然后依次填写视频标题和标签。完成上述操作后,在发布地点(下一行)下,会弹出选择账号,选择要发送的组,然后同时完成一个视频的发送,真正解放双手,节省时间。 !今日头条视频多账号自动群发工具

Emedia Assistant:同时发布图片、文字和短视频的软件。为了希望获得更好的曝光率,大型多媒体可以有选择地注册看点、爱奇艺等几十个高流量的内容平台。假设你只同步上传图片和文字后,8个平台80%的时间都是半小时,正好你还需要同步视频。 10个平台估计上下60分钟。此外,您还需要确保所有这些都成功发布。在实现全平台运营的结果后,将尤为明显。内容分发对效率影响很大,但只要使用易媒体助手这个工具,就可以轻松一键将文章和视频发送到几十个平台。只需七八分钟即可完成配送,彻底解放劳动力。

部分数据合作伙伴似乎不清楚。目前,他们每天检查新的相关数据宝藏已经相当强大网站。这些不仅是数据分析,还可以有效改善我们的内容。流行,然后我发现了这些强大的日常数据工具,应该可以帮助编辑:震撼商业眼睛 查看全部

今日头条文章采集软件(【易媒助手9大特色功能】+平台支持40+主流新媒体平台)

Emedia Assistant:内容投放工具有望获得可喜的广告份额。通常个人、公司选择入驻观看点、全国小视频等10多个热门自媒体平台,如果只同步文章,分发到8个平台需要近20分钟,并且它恰好有更多的长视频。 10个平台大约需要一个小时,需要确保所有上传完成。达到目的后,你会觉得每次同步真的很费时费力,只需要借助易媒体助手的分发软件,轻松将稿件和视频同时上传到30多个平台。上传只需七八分钟,排名不高。

视频图文一键上传结束,我来操作一键发布视频,你聪明,分分钟学会,点击下载视频(上图菜单部分),在为了节省以后的时间,这里是默认的分类设置好的,在本地添加您的视频内容后,在下面的视频内容周围填写标题,介绍和标签。当您填写完毕后,我们只需点击此处发布,就会出现要发布的帐户。选择您要发布的群组。一次性分发内容,比一份一份发布节省太多时间。今日头条视频多账号自动群发工具

舆情数据文章写个大佬,实现10万+的创造,一定要关注热点事件,挖掘可以参考的热点。直接有效的就是看热搜榜的内容,下面自媒体一般人都在用:易媒体助手,一帆千官

【EasyMedia 助手的 9 个功能】

1.40+平台支持:支持40+主流新媒体平台,新平台不断对接

2.1000+账户管理:轻松支持1000+账户管理,全新底层优化设计,自动记忆账户秘密,自动登录,无论多少账户都不怕挑战

3.爆文系统:实时采集热点文章,视频,让你轻松实时热点,打造局部10万+

4.AI智能改写:轻松改写收录,让你推广、关键词覆盖、软文等任务如虎添翼

5.一键分发:一键轻松分发文章、视频、小视频、微动到30+主流平台

6.团队管理:支持创建子账号,实现屏蔽收入、账号密码、员工操作统计等功能

7.原创度数检测:基于3大搜索引擎,一键检测文章原创度数,复查复核工具

8.微信帖子:支持一键发布微信帖子到:微头条、百家新闻、微博等平台

9.数据概览:一键查看平台所有收入、播放、阅读等数据

数据似乎还没有被注意到。事实上,它是一个非常有用的日常数据宝藏网站。这种网站不仅完整,而且有效。帮助我们使视频看起来更好。下面我喜欢用这些强大的工具实时动态微信热点文章,希望对各位编辑有所帮助:搜狗指数今日头条视频多账号自动群发工具

易媒体助手添加媒体账号功能需要通过您的账号完成,所以添加账号并选择您要操作的平台。如果是第一次使用,请用账号和密码登录,不要扫码登录。 自媒体号码。今日头条视频多账号自动群发工具

视频素材与文章的写作要求相同。其他类似的材料也是必不可少的。缺一不可的是,视频内容的整合还是要以其他热门视频为基础。如果你积累了很多内容源,你就可以完成内容。总的来说,它可能是非常高质量的。接下来我就数了几个特别实用的素材站,一定对“受苦编辑”有帮助:youtube、Vidsplay

一键分发视频,接下来我来操作一下如何一键分发视频,首先点击“发送视频”(在软件顶部),为了节省以后的时间,这里先设置默认分类,然后上传。发布视频,然后依次填写视频标题和标签。完成上述操作后,在发布地点(下一行)下,会弹出选择账号,选择要发送的组,然后同时完成一个视频的发送,真正解放双手,节省时间。 !今日头条视频多账号自动群发工具

Emedia Assistant:同时发布图片、文字和短视频的软件。为了希望获得更好的曝光率,大型多媒体可以有选择地注册看点、爱奇艺等几十个高流量的内容平台。假设你只同步上传图片和文字后,8个平台80%的时间都是半小时,正好你还需要同步视频。 10个平台估计上下60分钟。此外,您还需要确保所有这些都成功发布。在实现全平台运营的结果后,将尤为明显。内容分发对效率影响很大,但只要使用易媒体助手这个工具,就可以轻松一键将文章和视频发送到几十个平台。只需七八分钟即可完成配送,彻底解放劳动力。

部分数据合作伙伴似乎不清楚。目前,他们每天检查新的相关数据宝藏已经相当强大网站。这些不仅是数据分析,还可以有效改善我们的内容。流行,然后我发现了这些强大的日常数据工具,应该可以帮助编辑:震撼商业眼睛

今日头条文章采集软件(今日头条欺骗广告主啊解决这些问题要求对背后相关原理)

采集交流 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2021-12-30 17:29

这主要得益于我们的预加载技术~搜狗高速浏览器号称“智能预取,速度革命”,其实也是类似的技术:在访问之前,先帮你加载相应的内容

预加载技术表面上看起来很简单,但实际上有一些问题需要解决:

1. 不能影响下游站的统计:预加载不能让下游站的统计虚高

2. 不要浪费用户宝贵的流量

3. 不能影响广告统计:不能欺骗广告商

解决这些问题需要对基本原理有所了解。我就简单说一下,有相关知识和背景的同学可以点进去。没有的同学我就多讲讲了,没必要:)

一般站点流量统计依赖于第三方平台,如Google Analytics、CNZZ、百度统计等。这些平台依靠Javascript来实现相关统计。因此,只要在预加载时不执行相关代码,就不会影响统计。

对于用户流量,主要是了解预加载的目的和网页流量的构成:预加载的目的是最大化打开速度,实现“二次打开”体验。网页流量的主要部分是图片(我们占总流量的95%),图片不是“秒开”的必要条件,所以只要预加载不加载图片,我们就可以得到一个“秒开”体验,流量成本极低

之前看到有同学抓拍分析今日头条应用,看到列表页有访问第三方广告统计平台的请求,大呼“今日头条”欺骗广告主。只能说,这些学生的模式被打破了———— 广告商不仅要统计点击次数,还要统计展示次数。您在列表页面上看到的都是对展示次数统计的请求。事实上,今日头条并没有预加载广告

可见,为了达到极致的用户体验,我们需要付出很多努力和创新。急需更多有理想、爱折腾、有活力的NB朋友加入,请私信我!我要你! 查看全部

今日头条文章采集软件(今日头条欺骗广告主啊解决这些问题要求对背后相关原理)

这主要得益于我们的预加载技术~搜狗高速浏览器号称“智能预取,速度革命”,其实也是类似的技术:在访问之前,先帮你加载相应的内容

预加载技术表面上看起来很简单,但实际上有一些问题需要解决:

1. 不能影响下游站的统计:预加载不能让下游站的统计虚高

2. 不要浪费用户宝贵的流量

3. 不能影响广告统计:不能欺骗广告商

解决这些问题需要对基本原理有所了解。我就简单说一下,有相关知识和背景的同学可以点进去。没有的同学我就多讲讲了,没必要:)

一般站点流量统计依赖于第三方平台,如Google Analytics、CNZZ、百度统计等。这些平台依靠Javascript来实现相关统计。因此,只要在预加载时不执行相关代码,就不会影响统计。

对于用户流量,主要是了解预加载的目的和网页流量的构成:预加载的目的是最大化打开速度,实现“二次打开”体验。网页流量的主要部分是图片(我们占总流量的95%),图片不是“秒开”的必要条件,所以只要预加载不加载图片,我们就可以得到一个“秒开”体验,流量成本极低

之前看到有同学抓拍分析今日头条应用,看到列表页有访问第三方广告统计平台的请求,大呼“今日头条”欺骗广告主。只能说,这些学生的模式被打破了———— 广告商不仅要统计点击次数,还要统计展示次数。您在列表页面上看到的都是对展示次数统计的请求。事实上,今日头条并没有预加载广告

可见,为了达到极致的用户体验,我们需要付出很多努力和创新。急需更多有理想、爱折腾、有活力的NB朋友加入,请私信我!我要你!

今日头条文章采集软件(今日头条文章采集软件,可以实现自动生成推送推荐列表)

采集交流 • 优采云 发表了文章 • 0 个评论 • 397 次浏览 • 2021-12-27 22:01

今日头条文章采集软件,可以实现自动生成推送推荐列表,方便编辑。如需要批量关键词采集,请在百度搜索“算法采集器”,下载安装在软件中,就可以采集各个平台的文章批量采集,自动标题,自动摘要,自动添加标签,自动投票分析排名,操作简单容易上手。

我公众号“菜刀说技术”上看到的,你可以参考下,还不错,你可以关注下。

谢邀,百度经验去水印,

微信公众号回复:公众号回复:头条回复:抖音

图文采集,软件也行,我最近用的是【文字采集网】可以实现采集知乎,头条,b站,快手的图文内容,用的是采集代码,

这还不简单,自媒体的推送信息是有时效性的,可以找一找专门的公众号推送信息的公众号采集软件,如果是为了省时间可以选择公众号那边的图文采集库。

我也是刚毕业不久的小白,做公众号推送,准备自己花时间写采集代码,

刚刚用手机下载了一个爱采客、采集助手、抠图宝、sogou图片等,但是都不成功。最后发现一个简单的方法。用微信采集公众号文章,参考文章,写一个评论,留自己的网站。

公众号采集、批量采集、粉丝公众号文章、头条,内容越来越丰富了,很多都是网上翻来翻去、翻不到的真正原创文章。不用码字的工作量、加上方便且效率高的工具、随时随地实现公众号文章采集。【微信公众号采集助手】。支持百度搜索、推荐、360搜索、阿里、搜狗、360搜索等。免费使用功能强大功能强大:基于微信后台的公众号文章采集、全网全文数据对比、全网全文段落采集、高清采集、全网全文图片采集,支持你的公众号的文章内容、音乐图片、视频素材,一键收藏全网全文,并自动生成文章或作者邮箱地址,实现信息共享,名片自动分享,发布评论等功能。

全网搜索信息展示页:微信公众号和粉丝动态,自定义卡片收藏。全网采集收藏功能:更有心思,可以自定义收藏不同网站的文章(收藏本公众号的文章,左下角会出现收藏的网站),感觉整个收藏列表中你最值得去做的是知道这个的好的文章了。当然本身公众号里的一些干货,也是你去采集的好方向。全网全文搜索页:在支持微信后台、搜狗百度等采集方式的情况下,同时同步收藏微信公众号里的不同公众号、不同网站的文章。

全网全文采集:你可以搜索全网所有的公众号,下载全网全文,对于知道里面有一些干货的素材文章,一定要用心去看,内容才会丰富,图片分享才有价值,否则,全是转载。内容质量和整体转发率是关键。一键生成采集页:发布完可以一键生成一个专属你公众号文章的。 查看全部

今日头条文章采集软件(今日头条文章采集软件,可以实现自动生成推送推荐列表)

今日头条文章采集软件,可以实现自动生成推送推荐列表,方便编辑。如需要批量关键词采集,请在百度搜索“算法采集器”,下载安装在软件中,就可以采集各个平台的文章批量采集,自动标题,自动摘要,自动添加标签,自动投票分析排名,操作简单容易上手。

我公众号“菜刀说技术”上看到的,你可以参考下,还不错,你可以关注下。

谢邀,百度经验去水印,

微信公众号回复:公众号回复:头条回复:抖音

图文采集,软件也行,我最近用的是【文字采集网】可以实现采集知乎,头条,b站,快手的图文内容,用的是采集代码,

这还不简单,自媒体的推送信息是有时效性的,可以找一找专门的公众号推送信息的公众号采集软件,如果是为了省时间可以选择公众号那边的图文采集库。

我也是刚毕业不久的小白,做公众号推送,准备自己花时间写采集代码,

刚刚用手机下载了一个爱采客、采集助手、抠图宝、sogou图片等,但是都不成功。最后发现一个简单的方法。用微信采集公众号文章,参考文章,写一个评论,留自己的网站。

公众号采集、批量采集、粉丝公众号文章、头条,内容越来越丰富了,很多都是网上翻来翻去、翻不到的真正原创文章。不用码字的工作量、加上方便且效率高的工具、随时随地实现公众号文章采集。【微信公众号采集助手】。支持百度搜索、推荐、360搜索、阿里、搜狗、360搜索等。免费使用功能强大功能强大:基于微信后台的公众号文章采集、全网全文数据对比、全网全文段落采集、高清采集、全网全文图片采集,支持你的公众号的文章内容、音乐图片、视频素材,一键收藏全网全文,并自动生成文章或作者邮箱地址,实现信息共享,名片自动分享,发布评论等功能。

全网搜索信息展示页:微信公众号和粉丝动态,自定义卡片收藏。全网采集收藏功能:更有心思,可以自定义收藏不同网站的文章(收藏本公众号的文章,左下角会出现收藏的网站),感觉整个收藏列表中你最值得去做的是知道这个的好的文章了。当然本身公众号里的一些干货,也是你去采集的好方向。全网全文搜索页:在支持微信后台、搜狗百度等采集方式的情况下,同时同步收藏微信公众号里的不同公众号、不同网站的文章。

全网全文采集:你可以搜索全网所有的公众号,下载全网全文,对于知道里面有一些干货的素材文章,一定要用心去看,内容才会丰富,图片分享才有价值,否则,全是转载。内容质量和整体转发率是关键。一键生成采集页:发布完可以一键生成一个专属你公众号文章的。

今日头条文章采集软件(微头条采集软件-可以采集今日头条,搜狐网)

采集交流 • 优采云 发表了文章 • 0 个评论 • 240 次浏览 • 2021-12-26 12:10

今日头条文章采集软件-可以采集今日头条,搜狐网,等前10大网站优质文章同步过来,无需登录账号,文章过滤过滤垃圾软文等内容!不懂代码也可以操作,安卓和苹果手机的都有【可以免费使用一年】微头条专用采集软件安卓机手机群发都可以!微头条专用采集软件微头条手机端采集同步!微头条采集软件采集软件安卓机安卓机手机微头条专用采集软件搜狗微头条手机端采集同步微头条专用采集软件。

一直在用5118文章采集器,效果挺不错的。

5118网站导航了解一下:

亲测最后一个采集效果好。

今日头条很容易采集到不良信息的。

今日头条,大家都知道他是大平台。现在头条作为搜索引擎中的一个流量网站。无论是做自媒体推广还是百度联盟都是非常有效果的。因为头条是自带流量属性的。他的自带流量属性体现在三个方面:1,流量大流量大,指得是头条是大流量网站。各大自媒体平台都会把头条作为优先引入的渠道。并且在头条渠道发表的文章基本上都是以推广或者软文的形式传播的。

正是因为头条是庞大的流量入口,所以通过在头条投放软文,来推广,去引流效果是非常可观的。2,内容质量高这个质量体现在两个方面,一个是文章的时效性,不同于其他的论坛等平台,头条的内容大部分都是处于当天发布的。二是文章的观点正确。在今日头条发布的文章也是属于话题讨论,阅读量过几千的几乎没有,阅读量过万的大多数是经过数据验证的原创文章。

有一定的阅读量是自带流量的。这就是为什么很多靠写软文或者搬运来赚钱的人。他们发布的时候都会申请原创来保证文章质量。原创文章质量上去了,带来的读者也就会更多。3,软文转化率高。软文的转化率是和你的标题关系非常大的。所以标题很重要。如果你是做技术性的,文章标题一定要有关键词。发布几篇标题引起关注的文章之后,对文章数据进行分析。

选取最有价值的几篇,转化率也会好很多。所以我们在注重内容质量的同时。一定要多研究如何蹭热点。蹭热点要蹭到用户的痛点和喜好点。软文转化率一定是最高的。就算你没有转化,但是数据好,你最多也是会降低停留时间。但如果你蹭到热点之后,数据不好。停留时间太长了,直接就降低你的平台的权重了。反而你软文写的好,很容易就把话题转化率做起来了。软文转化率最高。 查看全部

今日头条文章采集软件(微头条采集软件-可以采集今日头条,搜狐网)

今日头条文章采集软件-可以采集今日头条,搜狐网,等前10大网站优质文章同步过来,无需登录账号,文章过滤过滤垃圾软文等内容!不懂代码也可以操作,安卓和苹果手机的都有【可以免费使用一年】微头条专用采集软件安卓机手机群发都可以!微头条专用采集软件微头条手机端采集同步!微头条采集软件采集软件安卓机安卓机手机微头条专用采集软件搜狗微头条手机端采集同步微头条专用采集软件。

一直在用5118文章采集器,效果挺不错的。

5118网站导航了解一下:

亲测最后一个采集效果好。

今日头条很容易采集到不良信息的。

今日头条,大家都知道他是大平台。现在头条作为搜索引擎中的一个流量网站。无论是做自媒体推广还是百度联盟都是非常有效果的。因为头条是自带流量属性的。他的自带流量属性体现在三个方面:1,流量大流量大,指得是头条是大流量网站。各大自媒体平台都会把头条作为优先引入的渠道。并且在头条渠道发表的文章基本上都是以推广或者软文的形式传播的。

正是因为头条是庞大的流量入口,所以通过在头条投放软文,来推广,去引流效果是非常可观的。2,内容质量高这个质量体现在两个方面,一个是文章的时效性,不同于其他的论坛等平台,头条的内容大部分都是处于当天发布的。二是文章的观点正确。在今日头条发布的文章也是属于话题讨论,阅读量过几千的几乎没有,阅读量过万的大多数是经过数据验证的原创文章。

有一定的阅读量是自带流量的。这就是为什么很多靠写软文或者搬运来赚钱的人。他们发布的时候都会申请原创来保证文章质量。原创文章质量上去了,带来的读者也就会更多。3,软文转化率高。软文的转化率是和你的标题关系非常大的。所以标题很重要。如果你是做技术性的,文章标题一定要有关键词。发布几篇标题引起关注的文章之后,对文章数据进行分析。

选取最有价值的几篇,转化率也会好很多。所以我们在注重内容质量的同时。一定要多研究如何蹭热点。蹭热点要蹭到用户的痛点和喜好点。软文转化率一定是最高的。就算你没有转化,但是数据好,你最多也是会降低停留时间。但如果你蹭到热点之后,数据不好。停留时间太长了,直接就降低你的平台的权重了。反而你软文写的好,很容易就把话题转化率做起来了。软文转化率最高。

今日头条文章采集软件(今日头条文章采集软件获取了市面上主流的知名网站)

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2022-02-17 01:04

今日头条文章采集软件获取了市面上主流的知名网站的文章采集工具,我们在这篇帖子中放置的是新榜app中的文章采集功能,下面是我们对新榜app的评测哦~首先打开软件就会有提示用户登录,登录后就可以开始使用啦,选择完感兴趣的网站,单击下方的搜索框,在输入框内输入你需要搜索的关键词,按下“搜索”后,软件就会对所在网站的文章进行匹配,将搜索到的结果中的文章全部列表并保存到你的地址栏中。

随后单击软件上方的搜索框右侧“全部”按钮,即可选择所需要的文章进行查看,只要选择需要的文章就可以直接搜索出来了。如果你有感兴趣的话题或文章,还可以直接添加至收藏里进行收藏。而且每日24小时都有更新。另外软件还会时不时的更新一些热门话题进行推送,完全不用担心每天所有的网站都会爆文了。看到网上很多文章的标题非常吸引人,又不敢点进去,又不想错过,没关系!新榜app中还有一个按钮,即“看一看”。

只要我们的网站有用户喜欢的文章,就可以直接点进去查看。并且“看一看”中包含了很多文章的各大平台的文章,包括豆瓣、知乎、头条号等等,都是非常不错的信息来源。其实软件还有很多内容值得好好体验一下哦,下面小编就不详细给大家介绍了,最近小编也是非常想用上这个工具,好心人可以私信我,小编送你一个最全的信息采集工具。 查看全部

今日头条文章采集软件(今日头条文章采集软件获取了市面上主流的知名网站)

今日头条文章采集软件获取了市面上主流的知名网站的文章采集工具,我们在这篇帖子中放置的是新榜app中的文章采集功能,下面是我们对新榜app的评测哦~首先打开软件就会有提示用户登录,登录后就可以开始使用啦,选择完感兴趣的网站,单击下方的搜索框,在输入框内输入你需要搜索的关键词,按下“搜索”后,软件就会对所在网站的文章进行匹配,将搜索到的结果中的文章全部列表并保存到你的地址栏中。

随后单击软件上方的搜索框右侧“全部”按钮,即可选择所需要的文章进行查看,只要选择需要的文章就可以直接搜索出来了。如果你有感兴趣的话题或文章,还可以直接添加至收藏里进行收藏。而且每日24小时都有更新。另外软件还会时不时的更新一些热门话题进行推送,完全不用担心每天所有的网站都会爆文了。看到网上很多文章的标题非常吸引人,又不敢点进去,又不想错过,没关系!新榜app中还有一个按钮,即“看一看”。

只要我们的网站有用户喜欢的文章,就可以直接点进去查看。并且“看一看”中包含了很多文章的各大平台的文章,包括豆瓣、知乎、头条号等等,都是非常不错的信息来源。其实软件还有很多内容值得好好体验一下哦,下面小编就不详细给大家介绍了,最近小编也是非常想用上这个工具,好心人可以私信我,小编送你一个最全的信息采集工具。

今日头条文章采集软件(今日头条文章采集软件支持微信qq文章转换成语音版本)

采集交流 • 优采云 发表了文章 • 0 个评论 • 688 次浏览 • 2022-02-14 13:03

今日头条文章采集软件是一款智能写作辅助软件,可以把任何文章一键转换成语音版本,然后翻译成英文文章。支持从微信,qq文章摘录,翻译成mp3格式。还支持关键词搜索文章,再搜索结果查看原文。不支持全网任何平台的任何文章采集。该软件使用方法如下。先选中需要采集的文章。如本文,选择微信。然后文章列表内再点击打开工具栏中语音识别,即可一键翻译文章中内容。同时可以再其他地方复制。最后保存为mp3格式,方便下次使用。

今日头条采集在今日头条采集器下载,100万种文章,

百度搜王晋康

都9102年了还没人能完全搞定头条号采集

今日头条可以采集近500w的文章

最新版本的头条采集器有注册功能。注册一个账号后就可以采集头条号文章,可以采集文章列表、文章详情页的文章,也可以采集文章。

据说今日头条采集api已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载,

今日头条采集api已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载,

最新版本的头条采集器已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载, 查看全部

今日头条文章采集软件(今日头条文章采集软件支持微信qq文章转换成语音版本)

今日头条文章采集软件是一款智能写作辅助软件,可以把任何文章一键转换成语音版本,然后翻译成英文文章。支持从微信,qq文章摘录,翻译成mp3格式。还支持关键词搜索文章,再搜索结果查看原文。不支持全网任何平台的任何文章采集。该软件使用方法如下。先选中需要采集的文章。如本文,选择微信。然后文章列表内再点击打开工具栏中语音识别,即可一键翻译文章中内容。同时可以再其他地方复制。最后保存为mp3格式,方便下次使用。

今日头条采集在今日头条采集器下载,100万种文章,

百度搜王晋康

都9102年了还没人能完全搞定头条号采集

今日头条可以采集近500w的文章

最新版本的头条采集器有注册功能。注册一个账号后就可以采集头条号文章,可以采集文章列表、文章详情页的文章,也可以采集文章。

据说今日头条采集api已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载,

今日头条采集api已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载,

最新版本的头条采集器已经开放,近期可以尝试尝试,目前今日头条采集器也有注册功能,扫描二维码下载,

今日头条文章采集软件( 一下当前今日头条的数据(据内部与公开数据综合))

采集交流 • 优采云 发表了文章 • 0 个评论 • 291 次浏览 • 2022-02-11 19:08

一下当前今日头条的数据(据内部与公开数据综合))

今日头条成立于2012年3月,到现在才4年。从十几名工程师到研发,到几百人,再到200多人。产品线从内涵笑话,到今日头条、今日特辑、今日电影等产品线。

一、产品背景

今日头条是为用户提供个性化信息的客户端。先给大家分享一下今日头条目前的数据(基于内部和公开数据):

1、文章捕获和分析

我们每天产生约10,000条原创新闻,包括重大新闻网站和地方台,以及一些小说、博客等文章。对于工程师来说,写一个 Crawler 并不难。

接下来,今日头条会人工审核过滤敏感的文章。此外,今日头条今日头条号还有大量原创文章加入内容选择队列。

接下来,我们将对文章进行文本分析,如分类、标注、主题提取、按文章或新闻的区域、流行度、权重计算。

2、用户建模

用户开始使用今日头条后,会对用户的行为日志进行实时分析。使用的工具如下:

我们挖掘用户的兴趣,学习用户的一举一动。主要使用:

与大多数模式一样,生成的用户模型数据存储在 MySQL/MongoDB(独立读写)和 Memcache/Redis 中。

随着用户数量的不断扩大,用户模型处理的机器集群数量也越来越多。在 2015 年之前,大约是 7,000 台。其中,用户推荐模型包括以下几个维度:

在这一点上,需要每时每刻提出建议。

3、新用户的“冷启动”

今日头条会被用户的手机、操作系统、版本等“识别”出来。另外,比如用户通过新浪微博等社交账号登录,今日头条会对用户进行初步的“画像”。用户在好友、粉丝、微博内容、转发、评论等维度。

分析用户的主要参数如下:

除了手机硬件,今日头条还分析了用户安装的应用。比如机型和APP结合分析,用小米,用三星,用苹果,除了用户的浏览器书签外,都不一样。今日头条会实时捕捉用户在APP频道上的动作。此外,还包括用户订阅的频道,如电影、笑话、产品等。

4、推荐系统

推荐系统,也称为推荐引擎。它是今日头条技术架构的核心部分。有两种类型的自动推荐和半自动推荐系统:

1) 自动推荐系统

这时候就需要一个高效大并发的推送系统,亿万用户都要接收。

2)半自动推荐系统

今日头条的渠道在技术方面是划分的,包括分类渠道、兴趣标签渠道、关键词渠道、文本分析等,这些都划分为相对独立的开发团队。目前已有300多个分类器,新的用户模型还在不断增加中。原创用户模型不需要撤消并且仍然可以运行。

今日头条号上线前,内容主要是抢其他平台的文章,然后去重,一年几百万,不算太大。主要是用户动作日志采集、兴趣采集、用户模型采集。

资讯类APP的技术指标,比如屏幕滑动、用户是否读完一篇文章、停留时间等等,都需要我们特别关注。

5、数据存储

今日头条使用MySQL或者Mongo持久化存储+Memched(Redis),分成很多库(一个大内存库),也尝试使用SSD产品。

今日头条的图片存储直接放在数据库中,文件采用分布式存储,读取时使用CDN。

6、消息推送

消息推送,为用户:及时获取信息。对于运营来说,它可以提高用户的活跃度。比如今天今日头条推送后,DAU可以提升20%左右。如果没有推送,将影响 DAU 约 10%(2015 年数据)。

推送后需要关注的ROI:点击率、点击量。能够监控应用程序卸载和推送禁用的数量。

今日头条推送的主要内容包括突发热点信息、有人评论回复、异地好友注册加入等。

在今日头条,推送也是个性化的:

例如:

据市消息:辽宁朝阳一则新闻事件,发给朝阳当地用户。

按兴趣:比如京东收购一号店,发给对互联网感兴趣的用户。

推送平台的工具和选择需要满足以下条件:

因此,推送后端应该提供日报、完整的数据后端,以及对A/B Test方案的支持。

部分推送系统使用自己的IDC,占用大量带宽,占用大量带宽。您可以使用像阿里云这样的服务,可以有效节省成本。

二、今日头条系统架构

三、今日头条微服务架构

今日头条拆分子系统,将大应用拆分成小应用,抽象出通用层用于代码复用。

系统的分层是典型的。重点是基础设施,我们希望通过基础设施来完善快速迭代、容灾等一系列工作,也希望各个业务团队能够更快地进行业务迭代和架构调整。

四、今日头条虚拟化PaaS平台规划

它通过三层实现,通过PaaS平台统一管理。提供通用的SaaS服务和通用的App执行引擎。底层是 IaaS 层。

IaaS 管理所有机器并集成公共云。今日头条的一些热点事件将在全国范围内推广和推送。网络带宽比较高。我们使用公共云来抽象出需要哪种类型的计算资源。基础设施结合了服务的思想,比如日志、监控等功能。企业可以在不关注细节的情况下享受基础设施提供的能力。

五、总结

今天头条的重要部分是:

数据生成和 采集