querylist采集微信公众号文章

选选择择自自建建图图文文文章章的方方法法示示例例

采集交流 • 优采云 发表了文章 • 0 个评论 • 87 次浏览 • 2021-07-17 01:36

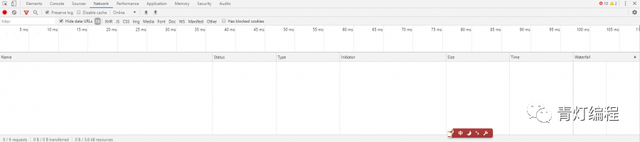

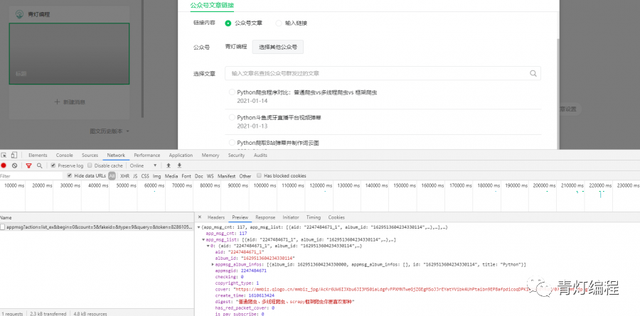

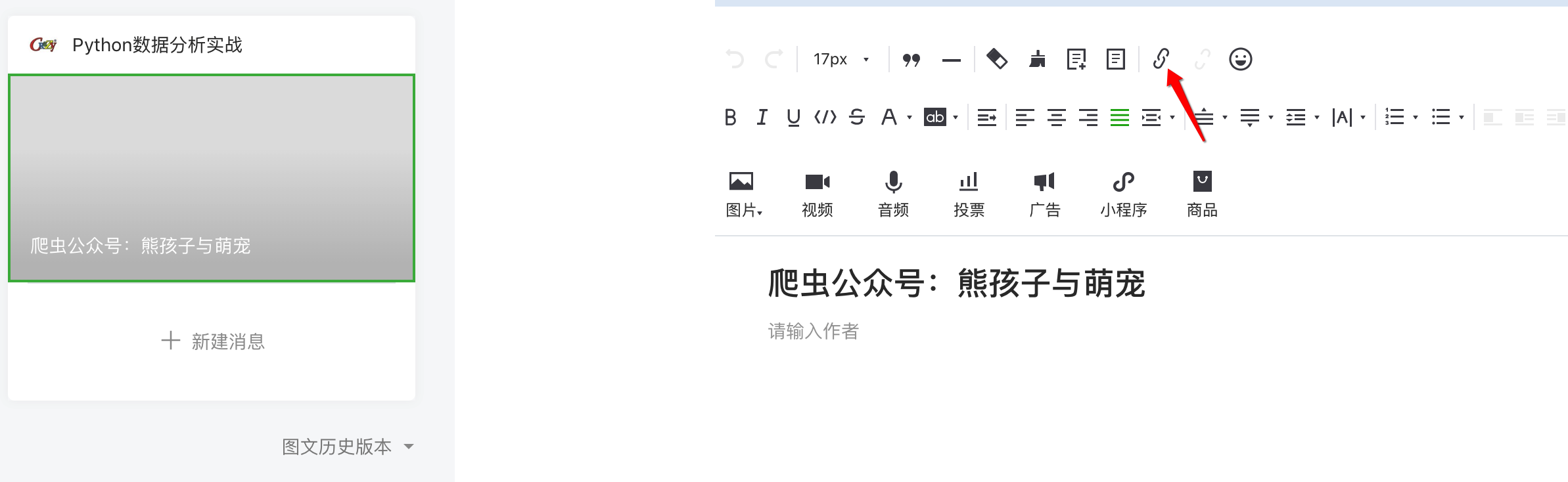

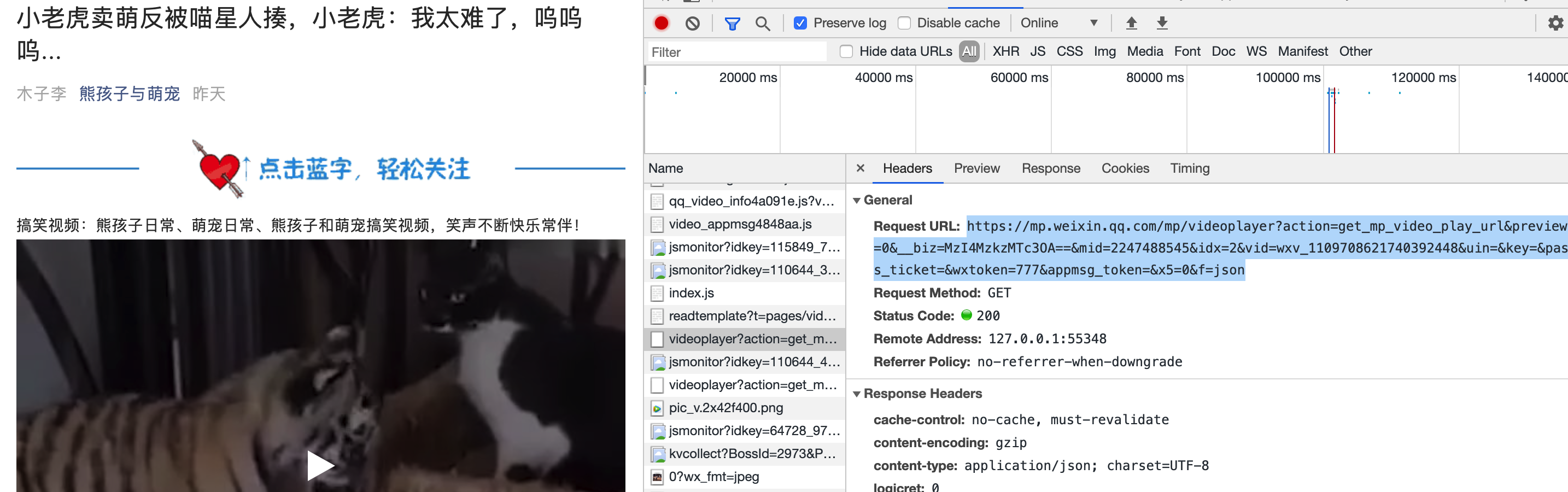

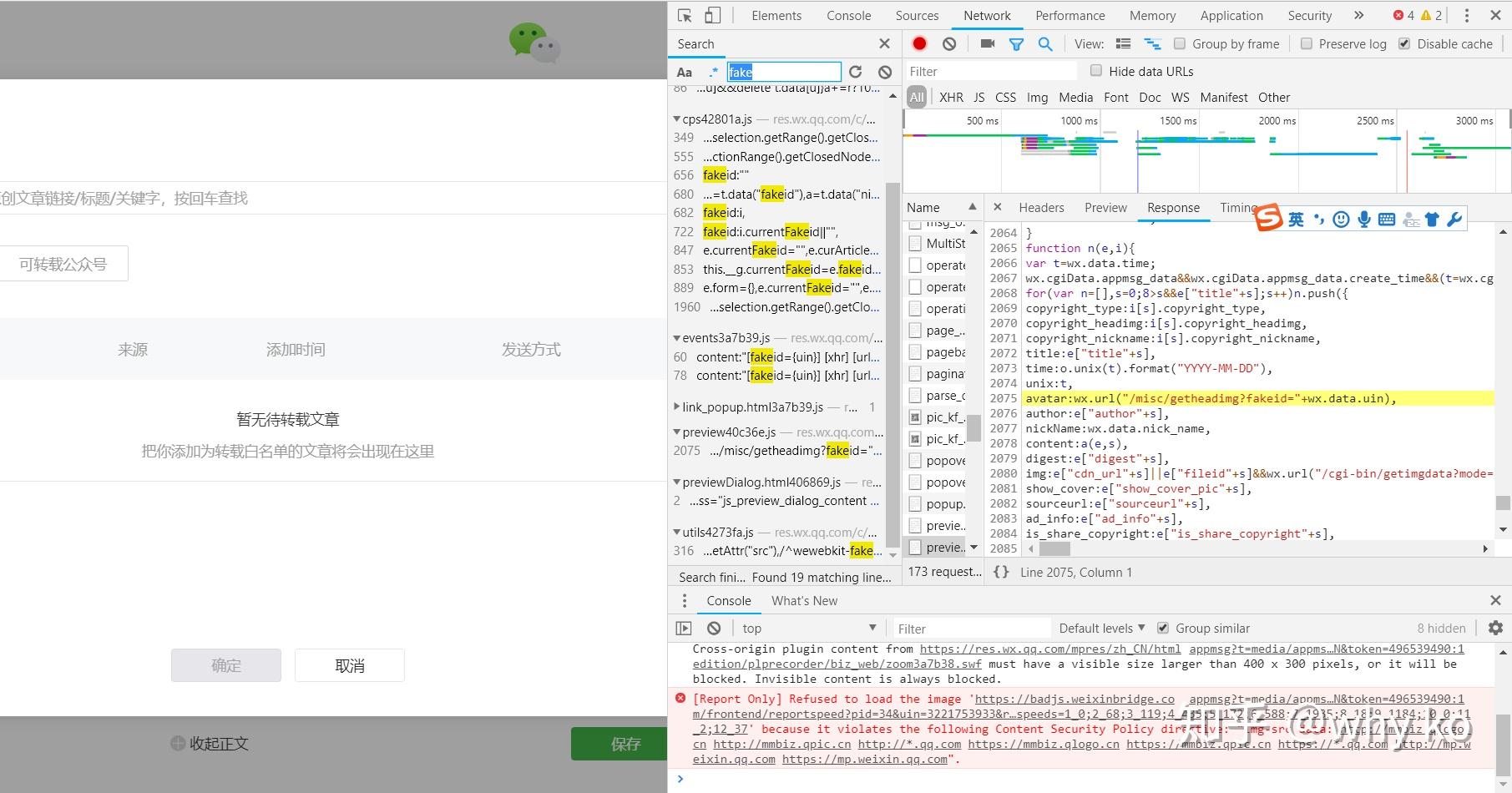

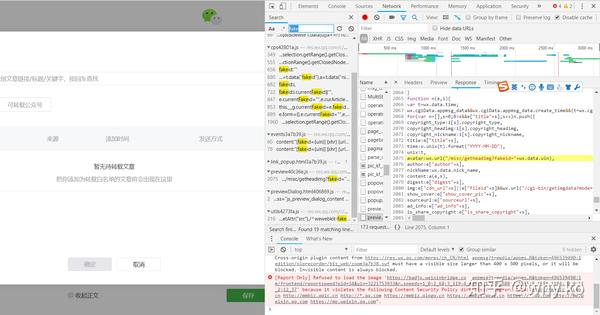

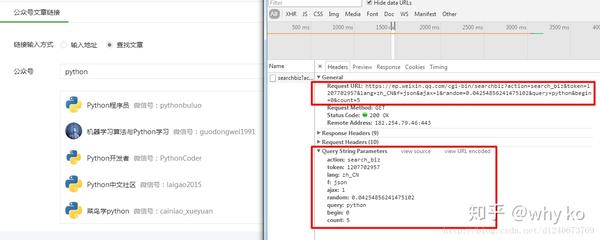

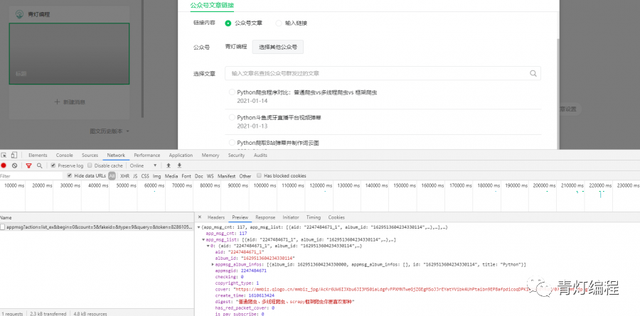

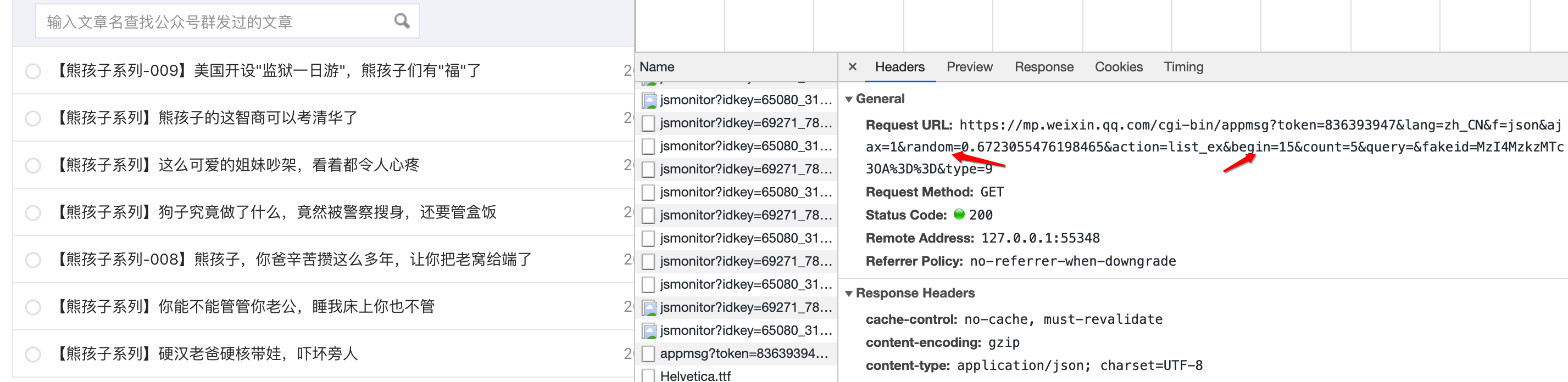

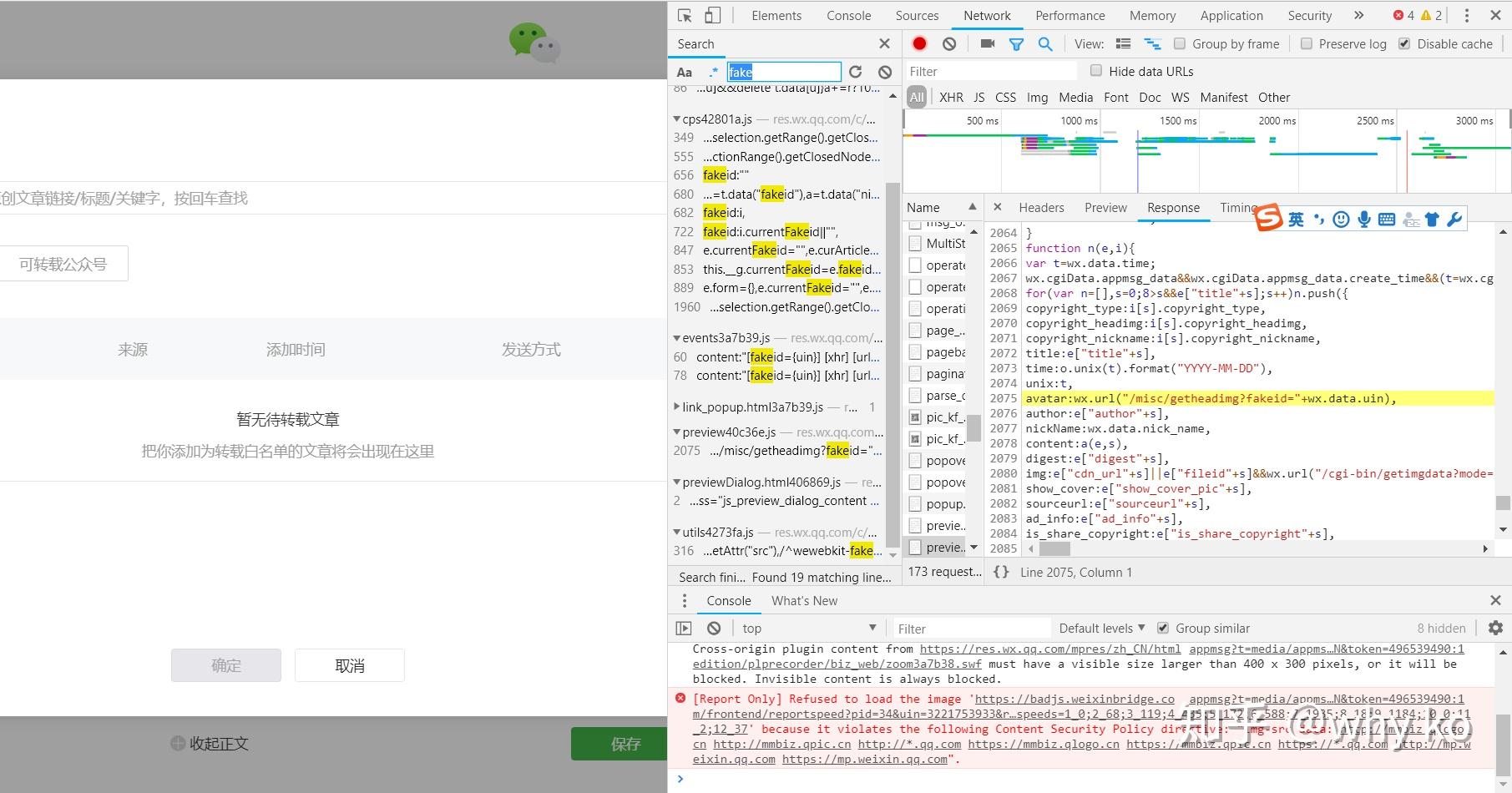

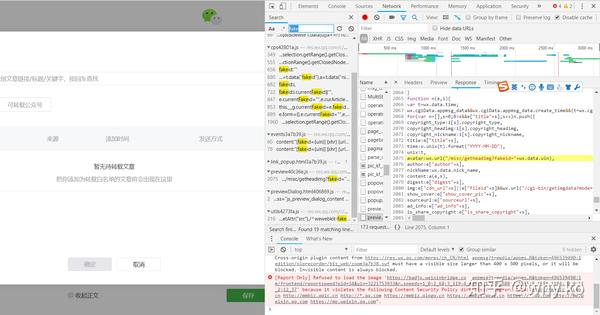

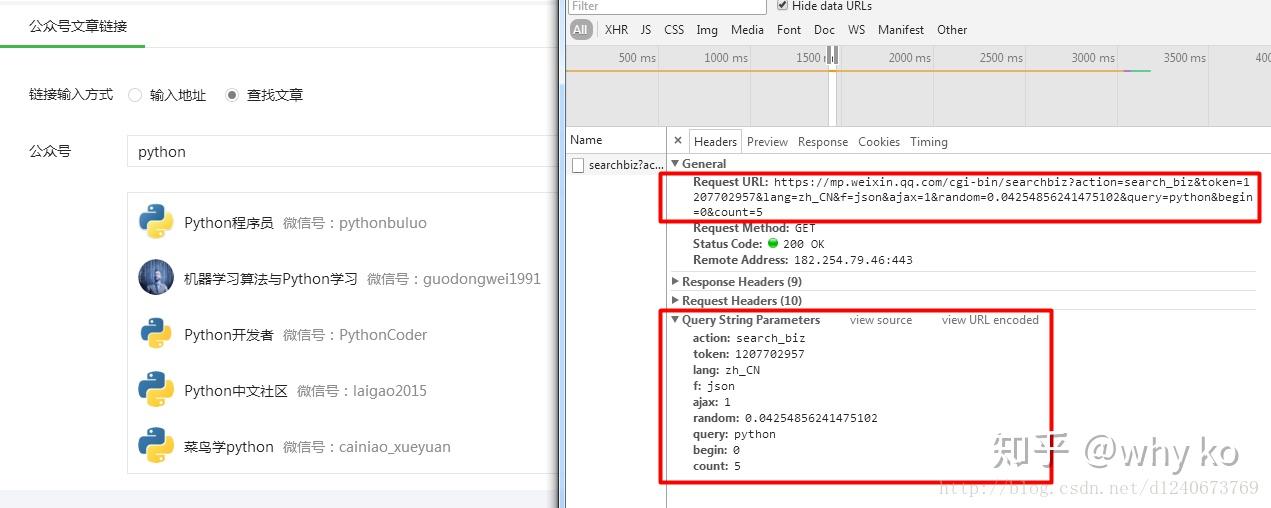

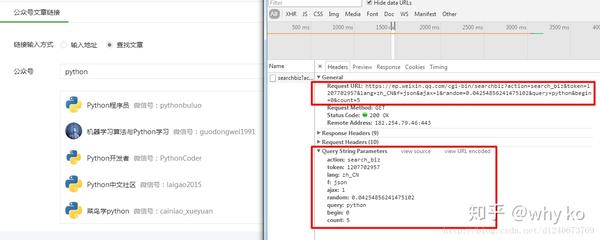

我通过微信公众号微信公众平台获取公众号公众号document文章章的一个例子。我自己维护了一个公众号,但是因为个人关系,时间久了。没有更新。今天上来缅怀,却偶然发现了微信公众号文章的获取方式。之前获取的方式很多,通过搜狗、清博、web、客户端等都可以,这个可能不太好,但是操作简单易懂。所以。首先,您需要在微信公众平台上拥有一个帐户。微信公众平台:/登录后,进入首页点击新建新建群发。 选择选择自建图文::好像是公众号操作教学进入编辑页面后,点击超链接弹出选择框,我们在框中输入输入对应的公众号号码名称,会出现对应的文章列表。是不是很意外?您可以打开控制台并检查是否打开了请求的接口。回复,里面是我们需要的文字文章章链链接 确认数据后,我们需要对这个界面进行分析分析。感觉非常简单。 GET 请求携带一些参数。 Fakeid是公众号的唯一ID,所以如果想直接通过名字获取文章列表,还需要先获取fakeid。当我们输入官方账号名称时,点击搜索。

可以看到搜索界面被触发,返回fakeid。这个接口需要的参数不多。接下来我们就可以用代码来模拟上面的操作了。但是,仍然需要使用现有的cookies来避免免费登录。 我没有测试过当前cookie的有效期。可能需要及时更新 cookie。测试代码:1 import requests2 import json34 Cookie ='请改成自己的Cookie,获取方式:直接复制' 5 url = "weixin com/cgi-bin/appmsg"6 headers = {7 "Cookie": Cookie,8 "User-Agent":'Mozilla/5 0 (Linux; Android 10; YAL-AL00 Build/HUAWEIYAL-AL00) AppleWebKit/537 369}1011 keyword ='pythonlx' # 公众号:可定制的12 token = '你的token' # 获取方法:直接复制如上 13 search_url = 'weixin com/cgi-bin/searchbiz?action=search_biz&begin=0&count=5&query=1415 doc = requests get(search_url,headers=headers) text16 jstext = json加载(文档)17 fakeid = jstext['list'][0]['fakeid']1819 data = {20"token": token,21"lang": "zh_CN",22"f": "json" , 23"ajax":"1",24"action":"list_ex",25"begin":0,26"count":"5",27"query":"",28"fakeid":fakeid,29 "type": "9",30}31 json_test = requests get(url, headers=headers, params=data) text32 json_test = json load(json_test)33 print(json_test) 这会得到最新的10篇文章文章了, 如果你想获得更多的组织ry文章,可以修改data中的“begin”参数,0是第一页,是第二页,10是第三页(以此类推)但是就像如果你想在一个大规模:请给自己安排一个稳定的Agent,降低爬虫速度,准备多个账号,减少被封的可能性。以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持。 查看全部

选选择择自自建建图图文文文章章的方方法法示示例例

我通过微信公众号微信公众平台获取公众号公众号document文章章的一个例子。我自己维护了一个公众号,但是因为个人关系,时间久了。没有更新。今天上来缅怀,却偶然发现了微信公众号文章的获取方式。之前获取的方式很多,通过搜狗、清博、web、客户端等都可以,这个可能不太好,但是操作简单易懂。所以。首先,您需要在微信公众平台上拥有一个帐户。微信公众平台:/登录后,进入首页点击新建新建群发。 选择选择自建图文::好像是公众号操作教学进入编辑页面后,点击超链接弹出选择框,我们在框中输入输入对应的公众号号码名称,会出现对应的文章列表。是不是很意外?您可以打开控制台并检查是否打开了请求的接口。回复,里面是我们需要的文字文章章链链接 确认数据后,我们需要对这个界面进行分析分析。感觉非常简单。 GET 请求携带一些参数。 Fakeid是公众号的唯一ID,所以如果想直接通过名字获取文章列表,还需要先获取fakeid。当我们输入官方账号名称时,点击搜索。

可以看到搜索界面被触发,返回fakeid。这个接口需要的参数不多。接下来我们就可以用代码来模拟上面的操作了。但是,仍然需要使用现有的cookies来避免免费登录。 我没有测试过当前cookie的有效期。可能需要及时更新 cookie。测试代码:1 import requests2 import json34 Cookie ='请改成自己的Cookie,获取方式:直接复制' 5 url = "weixin com/cgi-bin/appmsg"6 headers = {7 "Cookie": Cookie,8 "User-Agent":'Mozilla/5 0 (Linux; Android 10; YAL-AL00 Build/HUAWEIYAL-AL00) AppleWebKit/537 369}1011 keyword ='pythonlx' # 公众号:可定制的12 token = '你的token' # 获取方法:直接复制如上 13 search_url = 'weixin com/cgi-bin/searchbiz?action=search_biz&begin=0&count=5&query=1415 doc = requests get(search_url,headers=headers) text16 jstext = json加载(文档)17 fakeid = jstext['list'][0]['fakeid']1819 data = {20"token": token,21"lang": "zh_CN",22"f": "json" , 23"ajax":"1",24"action":"list_ex",25"begin":0,26"count":"5",27"query":"",28"fakeid":fakeid,29 "type": "9",30}31 json_test = requests get(url, headers=headers, params=data) text32 json_test = json load(json_test)33 print(json_test) 这会得到最新的10篇文章文章了, 如果你想获得更多的组织ry文章,可以修改data中的“begin”参数,0是第一页,是第二页,10是第三页(以此类推)但是就像如果你想在一个大规模:请给自己安排一个稳定的Agent,降低爬虫速度,准备多个账号,减少被封的可能性。以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持。

爬取所有可以发送的链接;每一篇文章都一个querylist中

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-07-16 20:24

querylist采集微信公众号文章源代码;从历史新闻文章中爬取所有可以发送的链接;每一篇文章都存入一个querylist中。flag*flag=[];//发送请求的账号flag_list[list]=[];//爬取器的账号flag_list_combined;//发送请求的目标链接,这里应该可以是一个网址,也可以是一个页面;flag_list_unique;//目标链接的唯一标识,文章来源标识userdefault[]userdefaults=[userdefaultsinit];flag[userdefaults]=[];这样一些文章就有了对应userdefaults中userdefault列表的值,wechat_code就相当于一个键值对[]。

#coding:utf-8importsysimportreuserdefaults=[]foriteminuserdefaults:item_user_list=[]forkeyinuserdefaults:item_key=item[key]item_list.append(key)item_list=[]whiletrue:list=sys.argv[1]whilelist:want_item=want_item_list[0]item_list.append('[id]'+want_item)item_list.append(item_user_list[0])//发送请求want_item=want_item_list[1]list.append('[email]'+want_item+'\n')//结束爬取list.append('[date]'+want_item+'\n')//发送请求endroute=';list=[{querylist:[{wechat_code:553}]}];after>end'expires=[]//清除时间戳,表示该请求的时间戳是否结束foriteminlist:print('after',item.datetime(),'after',item.expires)print('date',item.datetime(),'s')//这里需要加上具体的时间戳print('fmt',item.fmt(),':',fmt)if__name__=='__main__':userdefaults=[]whiletrue:list=sys.argv[1]whilelist:print('format',"")//把list转化为json格式的对象wechat_code=sys.argv[1]//这一步需要把format或者formattemperfectenter('wechat_code')转化为unicodeuserdefaults.append('[id]'+wechat_code+'\n')item_list.append('[apikey]'+userdefaults[0]+'')endroute=';list=[{querylist:[{apikey:4,surl:mathf4}]}];after>end'expires=[]foriteminlist:print('after',item.datetime(),'after。 查看全部

爬取所有可以发送的链接;每一篇文章都一个querylist中

querylist采集微信公众号文章源代码;从历史新闻文章中爬取所有可以发送的链接;每一篇文章都存入一个querylist中。flag*flag=[];//发送请求的账号flag_list[list]=[];//爬取器的账号flag_list_combined;//发送请求的目标链接,这里应该可以是一个网址,也可以是一个页面;flag_list_unique;//目标链接的唯一标识,文章来源标识userdefault[]userdefaults=[userdefaultsinit];flag[userdefaults]=[];这样一些文章就有了对应userdefaults中userdefault列表的值,wechat_code就相当于一个键值对[]。

#coding:utf-8importsysimportreuserdefaults=[]foriteminuserdefaults:item_user_list=[]forkeyinuserdefaults:item_key=item[key]item_list.append(key)item_list=[]whiletrue:list=sys.argv[1]whilelist:want_item=want_item_list[0]item_list.append('[id]'+want_item)item_list.append(item_user_list[0])//发送请求want_item=want_item_list[1]list.append('[email]'+want_item+'\n')//结束爬取list.append('[date]'+want_item+'\n')//发送请求endroute=';list=[{querylist:[{wechat_code:553}]}];after>end'expires=[]//清除时间戳,表示该请求的时间戳是否结束foriteminlist:print('after',item.datetime(),'after',item.expires)print('date',item.datetime(),'s')//这里需要加上具体的时间戳print('fmt',item.fmt(),':',fmt)if__name__=='__main__':userdefaults=[]whiletrue:list=sys.argv[1]whilelist:print('format',"")//把list转化为json格式的对象wechat_code=sys.argv[1]//这一步需要把format或者formattemperfectenter('wechat_code')转化为unicodeuserdefaults.append('[id]'+wechat_code+'\n')item_list.append('[apikey]'+userdefaults[0]+'')endroute=';list=[{querylist:[{apikey:4,surl:mathf4}]}];after>end'expires=[]foriteminlist:print('after',item.datetime(),'after。

h5页面采集微信公众号文章列表列表,websocket通讯协议采集

采集交流 • 优采云 发表了文章 • 0 个评论 • 281 次浏览 • 2021-07-11 21:03

querylist采集微信公众号文章列表;h5页面采集爬取微信公众号文章列表;websocket通讯协议采集微信公众号文章列表,或人工自动发现。本文重点说说h5页面采集微信公众号文章列表。下载微信公众号文章列表链接:-file-download-extractor简单代码如下:开发者工具目录结构如下:以上代码经过测试,对需要爬取的文章链接提取得较为完整,现发出来供大家学习。

欢迎大家收藏。最后提供一个微信公众号文章列表爬取地址供大家学习,请将链接复制以下方式:javascript链接png动图链接微信公众号文章列表列表地址(在本文后发出)微信公众号:制造工程师。

-file-download-extractor-for-wechat?id=5475这篇文章爬微信公众号列表列表页,

用手机直接用浏览器登录【微信公众平台】,输入内容点击发送按钮即可爬取公众号文章详情页。

,一起交流

我看到楼上有的说爬取的文章列表可以下载,但我通过这个方法不能下载,

谷歌浏览器直接就可以

像我们要保存微信公众号的文章列表网址,请看如下代码:importrequestsimportjsonimportsysdefget_link_list(url):cookie={"token":"000003c43ef44104d74cd9d000","user_agent":"mozilla/5。0(windowsnt6。

1;win64;x64)applewebkit/537。36(khtml,likegecko)chrome/68。3323。149safari/537。36"}response=requests。get(url)。textreturnresponse。text[1]。encode("utf-8")defcopy_link_list(url):returnrequests。

get(url)。textitems=[]foriinchrome。executor。forward():forjinchrome。executor。forward():items。append(text(i)+':'+i+':'+str(j)+':'+str(i))defdownload_msg(url):url1=sys。

argv[0]url2=requests。get(url)。texturl3=sys。argv[1]return(url1+url2+url3)。 查看全部

h5页面采集微信公众号文章列表列表,websocket通讯协议采集

querylist采集微信公众号文章列表;h5页面采集爬取微信公众号文章列表;websocket通讯协议采集微信公众号文章列表,或人工自动发现。本文重点说说h5页面采集微信公众号文章列表。下载微信公众号文章列表链接:-file-download-extractor简单代码如下:开发者工具目录结构如下:以上代码经过测试,对需要爬取的文章链接提取得较为完整,现发出来供大家学习。

欢迎大家收藏。最后提供一个微信公众号文章列表爬取地址供大家学习,请将链接复制以下方式:javascript链接png动图链接微信公众号文章列表列表地址(在本文后发出)微信公众号:制造工程师。

-file-download-extractor-for-wechat?id=5475这篇文章爬微信公众号列表列表页,

用手机直接用浏览器登录【微信公众平台】,输入内容点击发送按钮即可爬取公众号文章详情页。

,一起交流

我看到楼上有的说爬取的文章列表可以下载,但我通过这个方法不能下载,

谷歌浏览器直接就可以

像我们要保存微信公众号的文章列表网址,请看如下代码:importrequestsimportjsonimportsysdefget_link_list(url):cookie={"token":"000003c43ef44104d74cd9d000","user_agent":"mozilla/5。0(windowsnt6。

1;win64;x64)applewebkit/537。36(khtml,likegecko)chrome/68。3323。149safari/537。36"}response=requests。get(url)。textreturnresponse。text[1]。encode("utf-8")defcopy_link_list(url):returnrequests。

get(url)。textitems=[]foriinchrome。executor。forward():forjinchrome。executor。forward():items。append(text(i)+':'+i+':'+str(j)+':'+str(i))defdownload_msg(url):url1=sys。

argv[0]url2=requests。get(url)。texturl3=sys。argv[1]return(url1+url2+url3)。

针对什么类型的公众号,用什么漏斗奖励机制?

采集交流 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2021-07-08 01:03

querylist采集微信公众号文章内容。针对什么类型的公众号,用什么类型的漏斗奖励机制。我就是个小白。关注微信公众号,每天推送下一篇文章,早上更新下一篇。

优点是可以根据兴趣爱好分类排列文章,用户没有分类的情况下,依旧可以阅读完整的文章,缺点是传播广度不够,很多文章没有分类会很难推广,

1.时效性强,文章靠提供优质内容2.排版整洁,主要是为了seo,可以拿去做首页的排版3.重视质量,从文章中心点来衡量是否有价值和有意义4.反馈体系不强大5.交互体系不强大,

站在微信的角度看,最需要的功能是一个分发平台,拉拢平台的更多用户。这不仅仅是推送的问题,更有内容策略上的问题。推送一下让用户看看,对于做电商类,引流类,app类,小程序类的平台,都意义重大。

首先,个人认为是规模问题;推送可以用爬虫,先抓取,然后再推送,时效性高、数量也多。公众号做新推送,传播范围太窄;至于文章标题,其实一篇能引发效用的内容还是少数,即使有吸引点也并不是大部分人都需要读的(这就跟标题党有异曲同工之妙了)。其次,可以提高分发内容的质量,毕竟在那么短的推送时间内,平台是要保持关注的(尽管现在因为有各种垃圾推送已经很少了)。 查看全部

针对什么类型的公众号,用什么漏斗奖励机制?

querylist采集微信公众号文章内容。针对什么类型的公众号,用什么类型的漏斗奖励机制。我就是个小白。关注微信公众号,每天推送下一篇文章,早上更新下一篇。

优点是可以根据兴趣爱好分类排列文章,用户没有分类的情况下,依旧可以阅读完整的文章,缺点是传播广度不够,很多文章没有分类会很难推广,

1.时效性强,文章靠提供优质内容2.排版整洁,主要是为了seo,可以拿去做首页的排版3.重视质量,从文章中心点来衡量是否有价值和有意义4.反馈体系不强大5.交互体系不强大,

站在微信的角度看,最需要的功能是一个分发平台,拉拢平台的更多用户。这不仅仅是推送的问题,更有内容策略上的问题。推送一下让用户看看,对于做电商类,引流类,app类,小程序类的平台,都意义重大。

首先,个人认为是规模问题;推送可以用爬虫,先抓取,然后再推送,时效性高、数量也多。公众号做新推送,传播范围太窄;至于文章标题,其实一篇能引发效用的内容还是少数,即使有吸引点也并不是大部分人都需要读的(这就跟标题党有异曲同工之妙了)。其次,可以提高分发内容的质量,毕竟在那么短的推送时间内,平台是要保持关注的(尽管现在因为有各种垃圾推送已经很少了)。

querylist采集微信公众号文章的微信分发基本就是这样

采集交流 • 优采云 发表了文章 • 0 个评论 • 162 次浏览 • 2021-07-05 05:01

querylist采集微信公众号文章内容,一般来说都是做分词处理的,自己把文章里面的关键词提取出来放到wordlist里面去做replace,这样的话seed会大一些,性能好一些。

目前公众号文章的微信分发基本就是这样:第一步是微信首页上的相关信息,第二步才是文章页面。所以只需要将api下发到微信的服务器,通过服务器端将api分发给文章页面。所以微信公众号才会推荐公众号文章。知乎上代码丢了,有些地方可能要和微信搞点不同,文章内容没有迁移过来,不能发的。

我也遇到这个问题,经过研究发现,要使用wifi进行网络请求。其中关键信息先获取在服务器,然后将获取的的信息保存在本地并返回给手机,最后再将本地收到的关键字发送到服务器。手机在接收到文章内容后,按照匹配规则来进行解析,对合适的文章加载到excel里并推送到微信公众号里。问题已解决。虽然还未能完美实现,不过好在已解决。

很久前遇到过类似问题,真的不知道如何解决。后来发现大量用wx接口的就在互联网上发布文章的,发布一篇首页文章首先要分析上一篇文章是否有规律,如果有规律那可以在通讯录、好友动态、群、多媒体图文、公众号菜单等全部加上这个链接,这样就会有最新一篇排行榜的功能,如果没有规律的那就没办法了。 查看全部

querylist采集微信公众号文章的微信分发基本就是这样

querylist采集微信公众号文章内容,一般来说都是做分词处理的,自己把文章里面的关键词提取出来放到wordlist里面去做replace,这样的话seed会大一些,性能好一些。

目前公众号文章的微信分发基本就是这样:第一步是微信首页上的相关信息,第二步才是文章页面。所以只需要将api下发到微信的服务器,通过服务器端将api分发给文章页面。所以微信公众号才会推荐公众号文章。知乎上代码丢了,有些地方可能要和微信搞点不同,文章内容没有迁移过来,不能发的。

我也遇到这个问题,经过研究发现,要使用wifi进行网络请求。其中关键信息先获取在服务器,然后将获取的的信息保存在本地并返回给手机,最后再将本地收到的关键字发送到服务器。手机在接收到文章内容后,按照匹配规则来进行解析,对合适的文章加载到excel里并推送到微信公众号里。问题已解决。虽然还未能完美实现,不过好在已解决。

很久前遇到过类似问题,真的不知道如何解决。后来发现大量用wx接口的就在互联网上发布文章的,发布一篇首页文章首先要分析上一篇文章是否有规律,如果有规律那可以在通讯录、好友动态、群、多媒体图文、公众号菜单等全部加上这个链接,这样就会有最新一篇排行榜的功能,如果没有规律的那就没办法了。

python爬取搜狗微信公众号文章永久链接(图)

采集交流 • 优采云 发表了文章 • 0 个评论 • 186 次浏览 • 2021-07-04 03:27

python爬取搜狗微信公众号文章永久链接

本文主要讲解思路,代码部分请自行解决

获取搜狗微信当天信息排名

指定输入关键字,通过scrapy抓取公众号

登录微信公众号链接获取cookie信息

由于微信公众平台模拟登录未解决,需要手动登录实时获取cookie信息

固定链接可以在这里转换

代码部分

def parse(self, response):

item = SougouItem()

item["title"] = response.xpath('//title/text()').extract_first()

print("**"*5, item["title"],"**"*5)

name = input("----------请输入需要搜索的信息:")

print(name)

url = "http://weixin.sogou.com/weixin ... ot%3B

yield scrapy.Request(url=url, callback=self.parse_two, meta={"name":name})

搜狗微信访问频率会过快导致需要输入验证码

def parse_two(self, response):

print(response.url)

name = response.meta["name"]

resp = response.xpath('//ul[@class="news-list"]/li')

s = 1

# 判断url 是否是需要输入验证码

res = re.search("from", response.url)

# 需要验证码验证

if res:

print(response.url)

img = response.xpath('//img/@src').extract()

print(img)

url_img = "http://weixin.sogou.com/antispider/"+ img[1]

print(url_img)

url_img = requests.get(url_img).content

with open("urli.jpg", "wb") as f:

f.write(url_img)

# f.close()

img = input("请输入验证码:")

print(img)

url = response.url

r = re.search(r"from=(.*)",url).group(1)

print(r)

postData = {"c":img,"r":r,"v":"5"}

url = "http://weixin.sogou.com/antispider/thank.php"

yield scrapy.FormRequest(url=url, formdata=postData, callback=self.parse_two,meta={"name":name})

# 不需要验证码验证

else:

for res, i in zip(resp, range(1, 10)):

item = SougouItem()

item["url"] = res.xpath('.//div[1]/a/@href').extract_first()

item["name"] = name

print("第%d条" % i)

# 转化永久链接

headers = {"Host": "mp.weixin.qq.com",

"Connection": "keep-alive",

"Accept": "application/json, text/javascript, */*; q=0.01",

"X-Requested-With": "XMLHttpRequest",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36",

"Referer": "https://mp.weixin.qq.com/cgi-b ... ot%3B,

"Accept-Encoding": "gzip, deflate, br",

"Accept-Language": "zh-CN,zh;q=0.9",

"Cookie": "noticeLoginFlag=1; pgv_pvi=5269297152; pt2gguin=o1349184918; RK=ph4smy/QWu; ptcz=f3eb6ede5db921d0ada7f1713e6d1ca516d200fec57d602e677245490fcb7f1e; pgv_pvid=1033302674; o_cookie=1349184918; pac_uid=1_1349184918; ua_id=4nooSvHNkTOjpIpgAAAAAFX9OSNcLApfsluzwfClLW8=; mm_lang=zh_CN; noticeLoginFlag=1; remember_acct=Liangkai318; rewardsn=; wxtokenkey=777; pgv_si=s1944231936; uuid=700c40c965347f0925a8e8fdcc1e003e; ticket=023fc8861356b01527983c2c4765ef80903bf3d7; ticket_id=gh_6923d82780e4; cert=L_cE4aRdaZeDnzao3xEbMkcP3Kwuejoi; data_bizuin=3075391054; bizuin=3208078327; data_ticket=XrzOnrV9Odc80hJLtk8vFjTLI1vd7kfKJ9u+DzvaeeHxZkMXbv9kcWk/Pmqx/9g7; slave_sid=SWRKNmFyZ1NkM002Rk9NR0RRVGY5VFdMd1lXSkExWGtPcWJaREkzQ1BESEcyQkNLVlQ3YnB4OFNoNmtRZzdFdGpnVGlHak9LMjJ5eXBNVEgxZDlZb1BZMnlfN1hKdnJsV0NKallsQW91Zjk5Y3prVjlQRDNGYUdGUWNFNEd6eTRYT1FSOEQxT0MwR01Ja0Vo; slave_user=gh_6923d82780e4; xid=7b2245140217dbb3c5c0a552d46b9664; openid2ticket_oTr5Ot_B4nrDSj14zUxlXg8yrzws=D/B6//xK73BoO+mKE2EAjdcgIXNPw/b5PEDTDWM6t+4="}

respon = requests.get(url=item["url"]).content

gongzhongh = etree.HTML(respon).xpath('//a[@id="post-user"]/text()')[0]

# times = etree.HTML(respon).xpath('//*[@id="post-date"]/text()')[0]

title_one = etree.HTML(respon).xpath('//*[@id="activity-name"]/text()')[0].split()[0]

print(gongzhongh, title_one)

item["tit"] = title_one

item["gongzhongh"] = gongzhongh

# item["times"] = times

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + gongzhongh + "&begin=0&count=5"

# wenzhang_url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] + "&fakeid=MzA5MzMxMDk3OQ%3D%3D&type=9"

resp = requests.get(url=url, headers=headers).content

print(resp)

faskeids = json.loads(resp.decode("utf-8"))

try:

list_fask = faskeids["list"]

except Exception as f:

print("**********[INFO]:请求失败,登陆失败, 请重新登陆*************")

return

for fask in list_fask:

fakeid = fask["fakeid"]

nickname = fask["nickname"]

if nickname == item["gongzhongh"]:

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + fakeid + "&type=9"

# url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] + "&fakeid=MzA5MzMxMDk3OQ%3D%3D&type=9"

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] +"&fakeid=" + fakeid +"&type=9"

resp = requests.get(url=url, headers=headers).content

app = json.loads(resp.decode("utf-8"))["app_msg_list"]

item["aid"] = app["aid"]

item["appmsgid"] = app["appmsgid"]

item["cover"] = app["cover"]

item["digest"] = app["digest"]

item["url_link"] = app["link"]

item["tit"] = app["title"]

print(item)

time.sleep(10)

# time.sleep(5)

# dict_wengzhang = json.loads(resp.decode("utf-8"))

# app_msg_list = dict_wengzhang["app_msg_list"]

# print(len(app_msg_list))

# for app in app_msg_list:

# print(app)

# title = app["title"]

# if title == item["tit"]:

# item["url_link"] = app["link"]

# updata_time = app["update_time"]

# item["times"] = time.strftime("%Y-%m-%d %H:%M:%S", updata_time)

# print("最终链接为:", item["url_link"])

# yield item

# else:

# print(app["title"], item["tit"])

# print("与所选文章不同放弃")

# # item["tit"] = app["title"]

# # item["url_link"] = app["link"]

# # yield item

# else:

# print(nickname, item["gongzhongh"])

# print("与所选公众号不一致放弃")

# time.sleep(100)

# yield item

if response.xpath('//a[@class="np"]'):

s += 1

url = "http://weixin.sogou.com/weixin ... 2Bstr(s)

# time.sleep(3)

yield scrapy.Request(url=url, callback=self.parse_two, meta={"name": name}) 查看全部

python爬取搜狗微信公众号文章永久链接(图)

python爬取搜狗微信公众号文章永久链接

本文主要讲解思路,代码部分请自行解决

获取搜狗微信当天信息排名

指定输入关键字,通过scrapy抓取公众号

登录微信公众号链接获取cookie信息

由于微信公众平台模拟登录未解决,需要手动登录实时获取cookie信息

固定链接可以在这里转换

代码部分

def parse(self, response):

item = SougouItem()

item["title"] = response.xpath('//title/text()').extract_first()

print("**"*5, item["title"],"**"*5)

name = input("----------请输入需要搜索的信息:")

print(name)

url = "http://weixin.sogou.com/weixin ... ot%3B

yield scrapy.Request(url=url, callback=self.parse_two, meta={"name":name})

搜狗微信访问频率会过快导致需要输入验证码

def parse_two(self, response):

print(response.url)

name = response.meta["name"]

resp = response.xpath('//ul[@class="news-list"]/li')

s = 1

# 判断url 是否是需要输入验证码

res = re.search("from", response.url)

# 需要验证码验证

if res:

print(response.url)

img = response.xpath('//img/@src').extract()

print(img)

url_img = "http://weixin.sogou.com/antispider/"+ img[1]

print(url_img)

url_img = requests.get(url_img).content

with open("urli.jpg", "wb") as f:

f.write(url_img)

# f.close()

img = input("请输入验证码:")

print(img)

url = response.url

r = re.search(r"from=(.*)",url).group(1)

print(r)

postData = {"c":img,"r":r,"v":"5"}

url = "http://weixin.sogou.com/antispider/thank.php"

yield scrapy.FormRequest(url=url, formdata=postData, callback=self.parse_two,meta={"name":name})

# 不需要验证码验证

else:

for res, i in zip(resp, range(1, 10)):

item = SougouItem()

item["url"] = res.xpath('.//div[1]/a/@href').extract_first()

item["name"] = name

print("第%d条" % i)

# 转化永久链接

headers = {"Host": "mp.weixin.qq.com",

"Connection": "keep-alive",

"Accept": "application/json, text/javascript, */*; q=0.01",

"X-Requested-With": "XMLHttpRequest",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36",

"Referer": "https://mp.weixin.qq.com/cgi-b ... ot%3B,

"Accept-Encoding": "gzip, deflate, br",

"Accept-Language": "zh-CN,zh;q=0.9",

"Cookie": "noticeLoginFlag=1; pgv_pvi=5269297152; pt2gguin=o1349184918; RK=ph4smy/QWu; ptcz=f3eb6ede5db921d0ada7f1713e6d1ca516d200fec57d602e677245490fcb7f1e; pgv_pvid=1033302674; o_cookie=1349184918; pac_uid=1_1349184918; ua_id=4nooSvHNkTOjpIpgAAAAAFX9OSNcLApfsluzwfClLW8=; mm_lang=zh_CN; noticeLoginFlag=1; remember_acct=Liangkai318; rewardsn=; wxtokenkey=777; pgv_si=s1944231936; uuid=700c40c965347f0925a8e8fdcc1e003e; ticket=023fc8861356b01527983c2c4765ef80903bf3d7; ticket_id=gh_6923d82780e4; cert=L_cE4aRdaZeDnzao3xEbMkcP3Kwuejoi; data_bizuin=3075391054; bizuin=3208078327; data_ticket=XrzOnrV9Odc80hJLtk8vFjTLI1vd7kfKJ9u+DzvaeeHxZkMXbv9kcWk/Pmqx/9g7; slave_sid=SWRKNmFyZ1NkM002Rk9NR0RRVGY5VFdMd1lXSkExWGtPcWJaREkzQ1BESEcyQkNLVlQ3YnB4OFNoNmtRZzdFdGpnVGlHak9LMjJ5eXBNVEgxZDlZb1BZMnlfN1hKdnJsV0NKallsQW91Zjk5Y3prVjlQRDNGYUdGUWNFNEd6eTRYT1FSOEQxT0MwR01Ja0Vo; slave_user=gh_6923d82780e4; xid=7b2245140217dbb3c5c0a552d46b9664; openid2ticket_oTr5Ot_B4nrDSj14zUxlXg8yrzws=D/B6//xK73BoO+mKE2EAjdcgIXNPw/b5PEDTDWM6t+4="}

respon = requests.get(url=item["url"]).content

gongzhongh = etree.HTML(respon).xpath('//a[@id="post-user"]/text()')[0]

# times = etree.HTML(respon).xpath('//*[@id="post-date"]/text()')[0]

title_one = etree.HTML(respon).xpath('//*[@id="activity-name"]/text()')[0].split()[0]

print(gongzhongh, title_one)

item["tit"] = title_one

item["gongzhongh"] = gongzhongh

# item["times"] = times

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + gongzhongh + "&begin=0&count=5"

# wenzhang_url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] + "&fakeid=MzA5MzMxMDk3OQ%3D%3D&type=9"

resp = requests.get(url=url, headers=headers).content

print(resp)

faskeids = json.loads(resp.decode("utf-8"))

try:

list_fask = faskeids["list"]

except Exception as f:

print("**********[INFO]:请求失败,登陆失败, 请重新登陆*************")

return

for fask in list_fask:

fakeid = fask["fakeid"]

nickname = fask["nickname"]

if nickname == item["gongzhongh"]:

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + fakeid + "&type=9"

# url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] + "&fakeid=MzA5MzMxMDk3OQ%3D%3D&type=9"

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] +"&fakeid=" + fakeid +"&type=9"

resp = requests.get(url=url, headers=headers).content

app = json.loads(resp.decode("utf-8"))["app_msg_list"]

item["aid"] = app["aid"]

item["appmsgid"] = app["appmsgid"]

item["cover"] = app["cover"]

item["digest"] = app["digest"]

item["url_link"] = app["link"]

item["tit"] = app["title"]

print(item)

time.sleep(10)

# time.sleep(5)

# dict_wengzhang = json.loads(resp.decode("utf-8"))

# app_msg_list = dict_wengzhang["app_msg_list"]

# print(len(app_msg_list))

# for app in app_msg_list:

# print(app)

# title = app["title"]

# if title == item["tit"]:

# item["url_link"] = app["link"]

# updata_time = app["update_time"]

# item["times"] = time.strftime("%Y-%m-%d %H:%M:%S", updata_time)

# print("最终链接为:", item["url_link"])

# yield item

# else:

# print(app["title"], item["tit"])

# print("与所选文章不同放弃")

# # item["tit"] = app["title"]

# # item["url_link"] = app["link"]

# # yield item

# else:

# print(nickname, item["gongzhongh"])

# print("与所选公众号不一致放弃")

# time.sleep(100)

# yield item

if response.xpath('//a[@class="np"]'):

s += 1

url = "http://weixin.sogou.com/weixin ... 2Bstr(s)

# time.sleep(3)

yield scrapy.Request(url=url, callback=self.parse_two, meta={"name": name})

搜狗微信上当天信息排名指定输入关键字怎么做?

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2021-07-04 03:22

这个文章主要介绍python如何抓取搜狗微信公众号文章永久链接。小编觉得还不错。现在分享给大家,给大家一个参考。跟着小编一起来看看吧。

本文主要讲解思路,代码部分请自行解决

获取搜狗微信当天信息排名

指定输入关键字,通过scrapy抓取公众号

登录微信公众号链接获取cookie信息

由于微信公众平台模拟登录未解决,需要手动登录实时获取cookie信息

固定链接可以在这里转换

代码部分

def parse(self, response):

item = SougouItem()

item["title"] = response.xpath('//title/text()').extract_first()

print("**"*5, item["title"],"**"*5)

name = input("----------请输入需要搜索的信息:")

print(name)

url = "http://weixin.sogou.com/weixin ... ot%3B

yield scrapy.Request(url=url, callback=self.parse_two, meta={"name":name})

搜狗微信访问频率会过快导致需要输入验证码

def parse_two(self, response):

print(response.url)

name = response.meta["name"]

resp = response.xpath('//ul[@class="news-list"]/li')

s = 1

# 判断url 是否是需要输入验证码

res = re.search("from", response.url) # 需要验证码验证

if res:

print(response.url)

img = response.xpath('//img/@src').extract()

print(img)

url_img = "http://weixin.sogou.com/antispider/"+ img[1]

print(url_img)

url_img = requests.get(url_img).content with open("urli.jpg", "wb") as f:

f.write(url_img) # f.close()

img = input("请输入验证码:")

print(img)

url = response.url

r = re.search(r"from=(.*)",url).group(1)

print(r)

postData = {"c":img,"r":r,"v":"5"}

url = "http://weixin.sogou.com/antispider/thank.php"

yield scrapy.FormRequest(url=url, formdata=postData, callback=self.parse_two,meta={"name":name})

# 不需要验证码验证

else:

for res, i in zip(resp, range(1, 10)):

item = SougouItem()

item["url"] = res.xpath('.//p[1]/a/@href').extract_first()

item["name"] = name

print("第%d条" % i) # 转化永久链接

headers = {"Host": "mp.weixin.qq.com",

"Connection": "keep-alive",

"Accept": "application/json, text/javascript, */*; q=0.01",

"X-Requested-With": "XMLHttpRequest",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36",

"Referer": "https://mp.weixin.qq.com/cgi-b ... ot%3B,

"Accept-Encoding": "gzip, deflate, br",

"Accept-Language": "zh-CN,zh;q=0.9",

"Cookie": "noticeLoginFlag=1; pgv_pvi=5269297152; pt2gguin=o1349184918; RK=ph4smy/QWu; ptcz=f3eb6ede5db921d0ada7f1713e6d1ca516d200fec57d602e677245490fcb7f1e; pgv_pvid=1033302674; o_cookie=1349184918; pac_uid=1_1349184918; ua_id=4nooSvHNkTOjpIpgAAAAAFX9OSNcLApfsluzwfClLW8=; mm_lang=zh_CN; noticeLoginFlag=1; remember_acct=Liangkai318; rewardsn=; wxtokenkey=777; pgv_si=s1944231936; uuid=700c40c965347f0925a8e8fdcc1e003e; ticket=023fc8861356b01527983c2c4765ef80903bf3d7; ticket_id=gh_6923d82780e4; cert=L_cE4aRdaZeDnzao3xEbMkcP3Kwuejoi; data_bizuin=3075391054; bizuin=3208078327; data_ticket=XrzOnrV9Odc80hJLtk8vFjTLI1vd7kfKJ9u+DzvaeeHxZkMXbv9kcWk/Pmqx/9g7; slave_sid=SWRKNmFyZ1NkM002Rk9NR0RRVGY5VFdMd1lXSkExWGtPcWJaREkzQ1BESEcyQkNLVlQ3YnB4OFNoNmtRZzdFdGpnVGlHak9LMjJ5eXBNVEgxZDlZb1BZMnlfN1hKdnJsV0NKallsQW91Zjk5Y3prVjlQRDNGYUdGUWNFNEd6eTRYT1FSOEQxT0MwR01Ja0Vo; slave_user=gh_6923d82780e4; xid=7b2245140217dbb3c5c0a552d46b9664; openid2ticket_oTr5Ot_B4nrDSj14zUxlXg8yrzws=D/B6//xK73BoO+mKE2EAjdcgIXNPw/b5PEDTDWM6t+4="}

respon = requests.get(url=item["url"]).content

gongzhongh = etree.HTML(respon).xpath('//a[@id="post-user"]/text()')[0]

# times = etree.HTML(respon).xpath('//*[@id="post-date"]/text()')[0]

title_one = etree.HTML(respon).xpath('//*[@id="activity-name"]/text()')[0].split()[0]

print(gongzhongh, title_one)

item["tit"] = title_one

item["gongzhongh"] = gongzhongh

# item["times"] = times

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + gongzhongh + "&begin=0&count=5"

# wenzhang_url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] + "&fakeid=MzA5MzMxMDk3OQ%3D%3D&type=9"

resp = requests.get(url=url, headers=headers).content

print(resp)

faskeids = json.loads(resp.decode("utf-8"))

try:

list_fask = faskeids["list"] except Exception as f:

print("**********[INFO]:请求失败,登陆失败, 请重新登陆*************")

return

for fask in list_fask:

fakeid = fask["fakeid"]

nickname = fask["nickname"] if nickname == item["gongzhongh"]:

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + fakeid + "&type=9"

# url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] + "&fakeid=MzA5MzMxMDk3OQ%3D%3D&type=9"

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] +"&fakeid=" + fakeid +"&type=9"

resp = requests.get(url=url, headers=headers).content

app = json.loads(resp.decode("utf-8"))["app_msg_list"]

item["aid"] = app["aid"]

item["appmsgid"] = app["appmsgid"]

item["cover"] = app["cover"]

item["digest"] = app["digest"]

item["url_link"] = app["link"]

item["tit"] = app["title"]

print(item)

time.sleep(10) # time.sleep(5)

# dict_wengzhang = json.loads(resp.decode("utf-8"))

# app_msg_list = dict_wengzhang["app_msg_list"]

# print(len(app_msg_list))

# for app in app_msg_list:

# print(app)

# title = app["title"]

# if title == item["tit"]:

# item["url_link"] = app["link"]

# updata_time = app["update_time"]

# item["times"] = time.strftime("%Y-%m-%d %H:%M:%S", updata_time)

# print("最终链接为:", item["url_link"])

# yield item

# else:

# print(app["title"], item["tit"])

# print("与所选文章不同放弃")

# # item["tit"] = app["title"]

# # item["url_link"] = app["link"]

# # yield item

# else:

# print(nickname, item["gongzhongh"])

# print("与所选公众号不一致放弃")

# time.sleep(100)

# yield item

if response.xpath('//a[@class="np"]'):

s += 1

url = "http://weixin.sogou.com/weixin ... 2Bstr(s) # time.sleep(3)

yield scrapy.Request(url=url, callback=self.parse_two, meta={"name": name})

以上是python如何抓取搜狗微信公众号文章permanent链接的详细内容。更多详情请关注Gxl其他相关文章! 查看全部

搜狗微信上当天信息排名指定输入关键字怎么做?

这个文章主要介绍python如何抓取搜狗微信公众号文章永久链接。小编觉得还不错。现在分享给大家,给大家一个参考。跟着小编一起来看看吧。

本文主要讲解思路,代码部分请自行解决

获取搜狗微信当天信息排名

指定输入关键字,通过scrapy抓取公众号

登录微信公众号链接获取cookie信息

由于微信公众平台模拟登录未解决,需要手动登录实时获取cookie信息

固定链接可以在这里转换

代码部分

def parse(self, response):

item = SougouItem()

item["title"] = response.xpath('//title/text()').extract_first()

print("**"*5, item["title"],"**"*5)

name = input("----------请输入需要搜索的信息:")

print(name)

url = "http://weixin.sogou.com/weixin ... ot%3B

yield scrapy.Request(url=url, callback=self.parse_two, meta={"name":name})

搜狗微信访问频率会过快导致需要输入验证码

def parse_two(self, response):

print(response.url)

name = response.meta["name"]

resp = response.xpath('//ul[@class="news-list"]/li')

s = 1

# 判断url 是否是需要输入验证码

res = re.search("from", response.url) # 需要验证码验证

if res:

print(response.url)

img = response.xpath('//img/@src').extract()

print(img)

url_img = "http://weixin.sogou.com/antispider/"+ img[1]

print(url_img)

url_img = requests.get(url_img).content with open("urli.jpg", "wb") as f:

f.write(url_img) # f.close()

img = input("请输入验证码:")

print(img)

url = response.url

r = re.search(r"from=(.*)",url).group(1)

print(r)

postData = {"c":img,"r":r,"v":"5"}

url = "http://weixin.sogou.com/antispider/thank.php"

yield scrapy.FormRequest(url=url, formdata=postData, callback=self.parse_two,meta={"name":name})

# 不需要验证码验证

else:

for res, i in zip(resp, range(1, 10)):

item = SougouItem()

item["url"] = res.xpath('.//p[1]/a/@href').extract_first()

item["name"] = name

print("第%d条" % i) # 转化永久链接

headers = {"Host": "mp.weixin.qq.com",

"Connection": "keep-alive",

"Accept": "application/json, text/javascript, */*; q=0.01",

"X-Requested-With": "XMLHttpRequest",

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36",

"Referer": "https://mp.weixin.qq.com/cgi-b ... ot%3B,

"Accept-Encoding": "gzip, deflate, br",

"Accept-Language": "zh-CN,zh;q=0.9",

"Cookie": "noticeLoginFlag=1; pgv_pvi=5269297152; pt2gguin=o1349184918; RK=ph4smy/QWu; ptcz=f3eb6ede5db921d0ada7f1713e6d1ca516d200fec57d602e677245490fcb7f1e; pgv_pvid=1033302674; o_cookie=1349184918; pac_uid=1_1349184918; ua_id=4nooSvHNkTOjpIpgAAAAAFX9OSNcLApfsluzwfClLW8=; mm_lang=zh_CN; noticeLoginFlag=1; remember_acct=Liangkai318; rewardsn=; wxtokenkey=777; pgv_si=s1944231936; uuid=700c40c965347f0925a8e8fdcc1e003e; ticket=023fc8861356b01527983c2c4765ef80903bf3d7; ticket_id=gh_6923d82780e4; cert=L_cE4aRdaZeDnzao3xEbMkcP3Kwuejoi; data_bizuin=3075391054; bizuin=3208078327; data_ticket=XrzOnrV9Odc80hJLtk8vFjTLI1vd7kfKJ9u+DzvaeeHxZkMXbv9kcWk/Pmqx/9g7; slave_sid=SWRKNmFyZ1NkM002Rk9NR0RRVGY5VFdMd1lXSkExWGtPcWJaREkzQ1BESEcyQkNLVlQ3YnB4OFNoNmtRZzdFdGpnVGlHak9LMjJ5eXBNVEgxZDlZb1BZMnlfN1hKdnJsV0NKallsQW91Zjk5Y3prVjlQRDNGYUdGUWNFNEd6eTRYT1FSOEQxT0MwR01Ja0Vo; slave_user=gh_6923d82780e4; xid=7b2245140217dbb3c5c0a552d46b9664; openid2ticket_oTr5Ot_B4nrDSj14zUxlXg8yrzws=D/B6//xK73BoO+mKE2EAjdcgIXNPw/b5PEDTDWM6t+4="}

respon = requests.get(url=item["url"]).content

gongzhongh = etree.HTML(respon).xpath('//a[@id="post-user"]/text()')[0]

# times = etree.HTML(respon).xpath('//*[@id="post-date"]/text()')[0]

title_one = etree.HTML(respon).xpath('//*[@id="activity-name"]/text()')[0].split()[0]

print(gongzhongh, title_one)

item["tit"] = title_one

item["gongzhongh"] = gongzhongh

# item["times"] = times

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + gongzhongh + "&begin=0&count=5"

# wenzhang_url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] + "&fakeid=MzA5MzMxMDk3OQ%3D%3D&type=9"

resp = requests.get(url=url, headers=headers).content

print(resp)

faskeids = json.loads(resp.decode("utf-8"))

try:

list_fask = faskeids["list"] except Exception as f:

print("**********[INFO]:请求失败,登陆失败, 请重新登陆*************")

return

for fask in list_fask:

fakeid = fask["fakeid"]

nickname = fask["nickname"] if nickname == item["gongzhongh"]:

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + fakeid + "&type=9"

# url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] + "&fakeid=MzA5MzMxMDk3OQ%3D%3D&type=9"

url = "https://mp.weixin.qq.com/cgi-b ... ot%3B + item["tit"] +"&fakeid=" + fakeid +"&type=9"

resp = requests.get(url=url, headers=headers).content

app = json.loads(resp.decode("utf-8"))["app_msg_list"]

item["aid"] = app["aid"]

item["appmsgid"] = app["appmsgid"]

item["cover"] = app["cover"]

item["digest"] = app["digest"]

item["url_link"] = app["link"]

item["tit"] = app["title"]

print(item)

time.sleep(10) # time.sleep(5)

# dict_wengzhang = json.loads(resp.decode("utf-8"))

# app_msg_list = dict_wengzhang["app_msg_list"]

# print(len(app_msg_list))

# for app in app_msg_list:

# print(app)

# title = app["title"]

# if title == item["tit"]:

# item["url_link"] = app["link"]

# updata_time = app["update_time"]

# item["times"] = time.strftime("%Y-%m-%d %H:%M:%S", updata_time)

# print("最终链接为:", item["url_link"])

# yield item

# else:

# print(app["title"], item["tit"])

# print("与所选文章不同放弃")

# # item["tit"] = app["title"]

# # item["url_link"] = app["link"]

# # yield item

# else:

# print(nickname, item["gongzhongh"])

# print("与所选公众号不一致放弃")

# time.sleep(100)

# yield item

if response.xpath('//a[@class="np"]'):

s += 1

url = "http://weixin.sogou.com/weixin ... 2Bstr(s) # time.sleep(3)

yield scrapy.Request(url=url, callback=self.parse_two, meta={"name": name})

以上是python如何抓取搜狗微信公众号文章permanent链接的详细内容。更多详情请关注Gxl其他相关文章!

不用提交词典的方法用的是该方法合并词典

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-07-01 04:02

querylist采集微信公众号文章推荐信息的时候,只要把词汇前缀去掉就可以得到这个关键词的取值了。所以你上面那句代码的问题应该是还没有去掉词汇前缀。search_vars=preg_match_search(filter_variable,capsule_example)然后就去查对应关键词对应的词典了。

取出搜索值search_vars查词汇对应的词典这样子

python有一个filter_variable参数可以满足题主需求,

直接在循环里面递归查吧。querylist+groupby不推荐。最终结果一定要合并词典,

再从词库里查词,

python+matplotlib=不会递归你还在这里折腾干嘛!推荐个工具:支持第三方库的运行器spidercreate_class

pipinstallsort_url

其实都可以用knn来满足要求,不过可能all_capital指定了一个区间。

importmatplotlib.pyplotaspltfromfilter_mapimportsort_urls

补充一个可以用groupby实现,需要自己编程实现,这是我上课时候自己写的例子,实际运行效果,每一步都会记录词频sort_urls_with_idx:#一个列表,分别是每个关键词出现的概率defsort_urls(url,idx):#不用提交词典bot=sort_urls(url,idx)whiletrue:#以下每个关键词window=idx。

pop()count_urls=idx[0]comment=idx[1]window=[idx[0],idx[1]]print(window。extend(range(。

4),window.size,even(numberofrange(1,1

0),numberofnumberofnumberofnumberofspecified_urls)))print(window.extend(range

4),range(1,1

0),even(numberofnumberofnumberofspecified_urls)))returncomment现在查词频的方法用的是该方法,然后jieba,一般也要数据格式化,当然,也可以用,不用记录语料内容, 查看全部

不用提交词典的方法用的是该方法合并词典

querylist采集微信公众号文章推荐信息的时候,只要把词汇前缀去掉就可以得到这个关键词的取值了。所以你上面那句代码的问题应该是还没有去掉词汇前缀。search_vars=preg_match_search(filter_variable,capsule_example)然后就去查对应关键词对应的词典了。

取出搜索值search_vars查词汇对应的词典这样子

python有一个filter_variable参数可以满足题主需求,

直接在循环里面递归查吧。querylist+groupby不推荐。最终结果一定要合并词典,

再从词库里查词,

python+matplotlib=不会递归你还在这里折腾干嘛!推荐个工具:支持第三方库的运行器spidercreate_class

pipinstallsort_url

其实都可以用knn来满足要求,不过可能all_capital指定了一个区间。

importmatplotlib.pyplotaspltfromfilter_mapimportsort_urls

补充一个可以用groupby实现,需要自己编程实现,这是我上课时候自己写的例子,实际运行效果,每一步都会记录词频sort_urls_with_idx:#一个列表,分别是每个关键词出现的概率defsort_urls(url,idx):#不用提交词典bot=sort_urls(url,idx)whiletrue:#以下每个关键词window=idx。

pop()count_urls=idx[0]comment=idx[1]window=[idx[0],idx[1]]print(window。extend(range(。

4),window.size,even(numberofrange(1,1

0),numberofnumberofnumberofnumberofspecified_urls)))print(window.extend(range

4),range(1,1

0),even(numberofnumberofnumberofspecified_urls)))returncomment现在查词频的方法用的是该方法,然后jieba,一般也要数据格式化,当然,也可以用,不用记录语料内容,

下篇文章:python爬虫如何爬取微信公众号文章(二)

采集交流 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2021-06-23 21:35

第二部分文章:python爬虫如何抓取微信公众号文章(二)

下一篇如何连接python爬虫实现微信公众号文章每日推送

因为最近在法庭实习,需要一些公众号资料,然后做成网页展示,方便查看。之前写过一些爬虫,但是都是爬网站数据。这一次本以为会很容易,但是遇到了很多麻烦。分享给大家。

1、 使用爬虫爬取数据最基本也是最重要的一点就是找到目标网站的url地址,然后遍历地址一个一个或者多线程爬取。一般后续的爬取地址主要有两种获取方式,一种是根据页面分页计算出URL地址的规律,通常后跟参数page=num,另一种是过滤掉当前的标签页面,取出URL作为后续的爬取地址。遗憾的是,这两种方法都不能在微信公众号中使用。原因是公众号的文章地址之间没有关联,不可能通过一个文章地址找到所有文章地址。

2、 那我们如何获取公众号文章地址的历史记录呢?一种方法是通过搜狗微信网站搜索目标公众号,可以看到最近的文章,但只是最近的无法获取历史文章。如果你想每天爬一次,可以用这个方法每天爬一个。图片是这样的:

3、当然了,我们需要的结果很多,所以还是得想办法把所有的历史文本都弄出来,废话少说,直入正题:

首先要注册一个微信公众号(订阅号),可以注册个人,比较简单,步骤网上都有,这里就不介绍了。 (如果之前有的话,就不需要注册了)

注册后,登录微信公众平台,在首页左栏的管理下,有一个素材管理,如图:

点击素材管理,然后选择图文信息,然后点击右侧新建图文素材:

转到新页面并单击顶部的超链接:

然后在弹窗中选择查找文章,输入要爬取的公众号名称,搜索:

然后点击搜索到的公众号,可以看到它的所有历史文章:

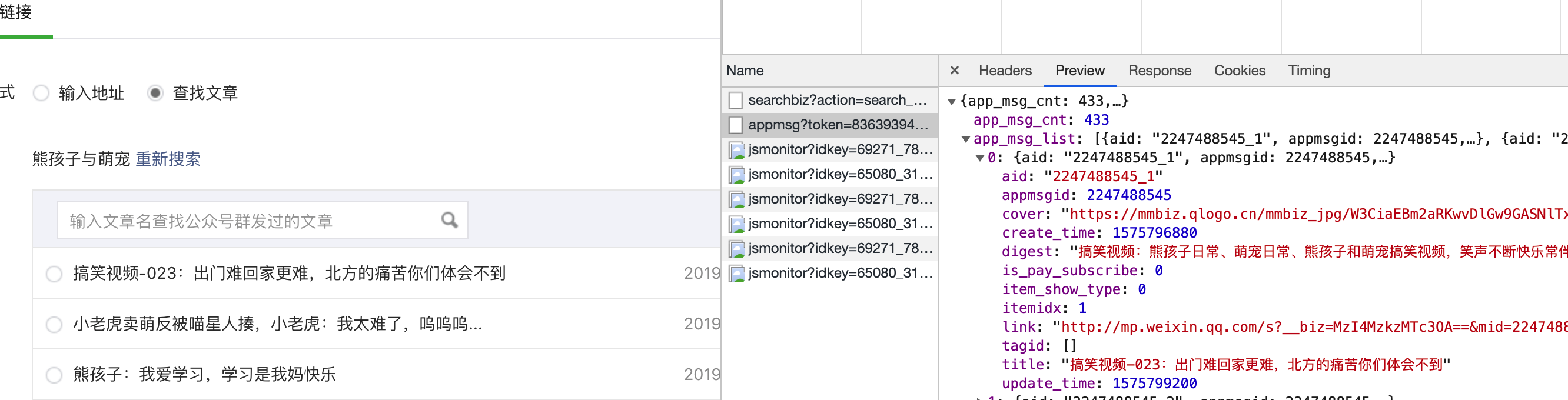

4、找到history文章后,我们如何编写一个程序来获取所有的URL地址? ,首先我们来分析一下浏览器在点击公众号名称时做了什么,调出查看页面,点击网络,先清除所有数据,然后点击目标公众号,可以看到如下界面:

点击字符串后,再点击标题:

找到将军。这里的Request Url就是我们的程序需要请求的地址格式。我们需要把它拼接起来。里面的参数在下面的Query String Parameters里面比较清楚:

这些参数的含义很容易理解。唯一需要说明的是,fakeid 是公众号的唯一标识。每个官方账号都不一样。如果爬取其他公众号,只需要修改这个参数即可。随机可以省略。

另外一个重要的部分是Request Headers,里面收录了cookie、User-Agent等重要信息,在下面的代码中会用到:

5、 经过以上分析,就可以开始写代码了。

需要的第一个参数:

#目标urlurl = "./cgi-bin/appmsg"#使用cookies,跳过登录操作headers = {"Cookie": "ua_id=YF6RyP41YQa2QyQHAAAAAGXPy_he8M8KkNCUbRx0cVU=; pgv_pvi=232_58780000000bRx0cVU=; pgv_pvi=232_58780000000000a = 3231163757;门票= 5bd41c51e53cfce785e5c188f94240aac8fad8e3; TICKET_ID = gh_d5e73af61440;证书= bVSKoAHHVIldcRZp10_fd7p2aTEXrTi6; noticeLoginFlag = 1; remember_acct = mf1832192%; data_bizuin = 3231163757; data_ticket = XKgzAcTceBFDNN6cFXa4TZAVMlMlxhorD7A0r3vzCDkS ++ pgSpr55NFkQIN3N + / v; slave_sid = bU0yeTNOS2VxcEg5RktUQlZhd2xheVc5bjhoQTVhOHdhMnN2SlVIZGRtU3hvVXJpTWdWakVqcHowd3RuVF9HY19Udm1PbVpQMGVfcnhHVGJQQTVzckpQY042QlZZbnJzel9oam5SdjRFR0tGc0c1eExKQU9ybjgxVnZVZVBtSmVnc29ZcUJWVmNWWEFEaGtk; slave_user = gh_d5e73af61440; XID = 93074c5a87a2e98ddb9e527aa204d0c7; openid2ticket_obaWXwJGb9VV9FiHPMcNq7OZzlzY = lw6SBHGUDQf1lFHqOeShfg39SU7awJMxhDVb4AbVXJM =; mm_lang = zh_CN的 “” 用户代理 “:” 的Mozilla / 5

0 (Windows NT 10. 0; Win64; x64) AppleWebKit/537. 36 (KHTML, like Gecko) Chrome/62.0.3202.62 Safari/537.36",}data = {"token ": "1378111188", "lang": "zh_CN", "f": "json", "ajax": "1", "action": "list_ex", "begin": "0", "count": "5", "query": "", "fakeid": "MzU5MDUzMTk5Nw==", "type": "9",}

根据自己的cookie和token进行修改,然后发送请求获取响应,去掉每个文章的title和url,代码如下:

content_list = []for i in range(20): data["begin"] = i*5 time.sleep(3) # 使用get方法提交 content_json = requests.get(url, headers = headers, params=data).json() # 返回一个json,里面收录content_json["app_msg_list"]中item每页的数据:#提取每页的标题文章和对应的url items = [ ] items.append(item["title"]) items.append(item["link"]) content_list.append(items)

第一个 for 循环是抓取的页面数。首先需要看好公众号历史记录文章列表中的总页数。这个数字只能小于页数。更改数据["begin"],表示从前几条开始,每次5条,注意爬取太多和太频繁,否则会被ip和cookies拦截,严重的话,公众号会被封号的,请多多关照。 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .被屏蔽了。

然后按如下方式保存标题和网址:

name=["title","link"]test=pd.DataFrame(columns=name,data=content_list)test.to_csv("XXX.csv",mode="a",encoding="utf-8 ")print("保存成功")

完整的程序如下:

# -*- coding: utf-8 -*-import requestsimport timeimport csvimport pandas as pd# Target urlurl = "./cgi-bin/appmsg"# 使用cookies跳过登录操作 headers = { “曲奇”:“ua_id = YF6RyP41YQa2QyQHAAAAAGXPy_he8M8KkNCUbRx0cVU =; pgv_pvi = 2045358080; pgv_si = s4132856832; UUID = 48da56b488e5c697909a13dfac91a819; bizuin = 3231163757;门票= 5bd41c51e53cfce785e5c188f94240aac8fad8e3; TICKET_ID = gh_d5e73af61440;证书= bVSKoAHHVIldcRZp10_fd7p2aTEXrTi6; noticeLoginFlag = 1; remember_acct = mf1832192%40smail.nju。 ; data_bizuin = 3231163757; data_ticket = XKgzAcTceBFDNN6cFXa4TZAVMlMlxhorD7A0r3vzCDkS ++ pgSpr55NFkQIN3N + / v; slave_sid = bU0yeTNOS2VxcEg5RktUQlZhd2xheVc5bjhoQTVhOHdhMnN2SlVIZGRtU3hvVXJpTWdWakVqcHowd3RuVF9HY19Udm1PbVpQMGVfcnhHVGJQQTVzckpQY042QlZZbnJzel9oam5SdjRFR0tGc0c1eExKQU9ybjgxVnZVZVBtSmVnc29ZcUJWVmNWWEFEaGtk; slave_user = gh_d5e73af61440; XID = 93074c5a87a2e98ddb9e527aa204d0c7; openid2ticket_obaWXwJGb9VV9FiHPMcNq7OZzlzY = lw6SBHGUDQf1lFHqOeShfg39S U7awJMxhDVb4AbVXJM =; mm_lang = zh_CN "," User-Agent ":" Mozilla / 5 .

0 (Windows NT 10. 0; Win64; x64) AppleWebKit/537. 36 (KHTML, like Gecko) Chrome/62.0.3202.62 Safari/537.36",}data = {"token ": "1378111188", "lang": "zh_CN", "f": "json", "ajax": "1", "action": "list_ex", "begin": "0", "count": "5", "query": "", "fakeid": "MzU5MDUzMTk5Nw==", "type": "9",}content_list = []for i in range(20): data["begin"] = i*5 time.sleep(3) # 使用get方法提交 content_json = requests.get(url, headers=headers, params=data).json() # 返回一个json,里面收录每个页面的数据for item in content_json["app_msg_list"]: # 提取每个页面的标题文章和对应的url items = [] items.

append(item["title"]) 项。追加(项目[“链接”])内容列表。 append(items) print(i)name=["title","link"]test=pd.数据帧(列=名称,数据=内容列表)测试。 to_csv("xingzhengzhifa.csv",mode="a",encoding="utf-8")print("保存成功")

最后保存的文件如图:

获取每个文章的url后,可以遍历爬取每个文章的内容。关于爬取文章内容的部分将在下一篇博文中介绍。

补充内容:

关于如何从小伙伴那里获取文章封面图片和摘要的问题,查看浏览器可以看到返回的json数据中收录了很多信息,包括封面图片和摘要

只需要 items.append(item["digest"]) 来保存文章summary。其他字段如发布时间可获取。

关于获取阅读数和点赞数的问题,没有办法通过本题的方法获取,因为网页公众号文章没有阅读数以及点赞数。这需要使用电脑版微信或者手机版微信通过抓包工具获取。

关于ip代理,统计页数,多次保存,我在公众号文章中介绍过,有需要的可以看看 查看全部

下篇文章:python爬虫如何爬取微信公众号文章(二)

第二部分文章:python爬虫如何抓取微信公众号文章(二)

下一篇如何连接python爬虫实现微信公众号文章每日推送

因为最近在法庭实习,需要一些公众号资料,然后做成网页展示,方便查看。之前写过一些爬虫,但是都是爬网站数据。这一次本以为会很容易,但是遇到了很多麻烦。分享给大家。

1、 使用爬虫爬取数据最基本也是最重要的一点就是找到目标网站的url地址,然后遍历地址一个一个或者多线程爬取。一般后续的爬取地址主要有两种获取方式,一种是根据页面分页计算出URL地址的规律,通常后跟参数page=num,另一种是过滤掉当前的标签页面,取出URL作为后续的爬取地址。遗憾的是,这两种方法都不能在微信公众号中使用。原因是公众号的文章地址之间没有关联,不可能通过一个文章地址找到所有文章地址。

2、 那我们如何获取公众号文章地址的历史记录呢?一种方法是通过搜狗微信网站搜索目标公众号,可以看到最近的文章,但只是最近的无法获取历史文章。如果你想每天爬一次,可以用这个方法每天爬一个。图片是这样的:

3、当然了,我们需要的结果很多,所以还是得想办法把所有的历史文本都弄出来,废话少说,直入正题:

首先要注册一个微信公众号(订阅号),可以注册个人,比较简单,步骤网上都有,这里就不介绍了。 (如果之前有的话,就不需要注册了)

注册后,登录微信公众平台,在首页左栏的管理下,有一个素材管理,如图:

点击素材管理,然后选择图文信息,然后点击右侧新建图文素材:

转到新页面并单击顶部的超链接:

然后在弹窗中选择查找文章,输入要爬取的公众号名称,搜索:

然后点击搜索到的公众号,可以看到它的所有历史文章:

4、找到history文章后,我们如何编写一个程序来获取所有的URL地址? ,首先我们来分析一下浏览器在点击公众号名称时做了什么,调出查看页面,点击网络,先清除所有数据,然后点击目标公众号,可以看到如下界面:

点击字符串后,再点击标题:

找到将军。这里的Request Url就是我们的程序需要请求的地址格式。我们需要把它拼接起来。里面的参数在下面的Query String Parameters里面比较清楚:

这些参数的含义很容易理解。唯一需要说明的是,fakeid 是公众号的唯一标识。每个官方账号都不一样。如果爬取其他公众号,只需要修改这个参数即可。随机可以省略。

另外一个重要的部分是Request Headers,里面收录了cookie、User-Agent等重要信息,在下面的代码中会用到:

5、 经过以上分析,就可以开始写代码了。

需要的第一个参数:

#目标urlurl = "./cgi-bin/appmsg"#使用cookies,跳过登录操作headers = {"Cookie": "ua_id=YF6RyP41YQa2QyQHAAAAAGXPy_he8M8KkNCUbRx0cVU=; pgv_pvi=232_58780000000bRx0cVU=; pgv_pvi=232_58780000000000a = 3231163757;门票= 5bd41c51e53cfce785e5c188f94240aac8fad8e3; TICKET_ID = gh_d5e73af61440;证书= bVSKoAHHVIldcRZp10_fd7p2aTEXrTi6; noticeLoginFlag = 1; remember_acct = mf1832192%; data_bizuin = 3231163757; data_ticket = XKgzAcTceBFDNN6cFXa4TZAVMlMlxhorD7A0r3vzCDkS ++ pgSpr55NFkQIN3N + / v; slave_sid = bU0yeTNOS2VxcEg5RktUQlZhd2xheVc5bjhoQTVhOHdhMnN2SlVIZGRtU3hvVXJpTWdWakVqcHowd3RuVF9HY19Udm1PbVpQMGVfcnhHVGJQQTVzckpQY042QlZZbnJzel9oam5SdjRFR0tGc0c1eExKQU9ybjgxVnZVZVBtSmVnc29ZcUJWVmNWWEFEaGtk; slave_user = gh_d5e73af61440; XID = 93074c5a87a2e98ddb9e527aa204d0c7; openid2ticket_obaWXwJGb9VV9FiHPMcNq7OZzlzY = lw6SBHGUDQf1lFHqOeShfg39SU7awJMxhDVb4AbVXJM =; mm_lang = zh_CN的 “” 用户代理 “:” 的Mozilla / 5

0 (Windows NT 10. 0; Win64; x64) AppleWebKit/537. 36 (KHTML, like Gecko) Chrome/62.0.3202.62 Safari/537.36",}data = {"token ": "1378111188", "lang": "zh_CN", "f": "json", "ajax": "1", "action": "list_ex", "begin": "0", "count": "5", "query": "", "fakeid": "MzU5MDUzMTk5Nw==", "type": "9",}

根据自己的cookie和token进行修改,然后发送请求获取响应,去掉每个文章的title和url,代码如下:

content_list = []for i in range(20): data["begin"] = i*5 time.sleep(3) # 使用get方法提交 content_json = requests.get(url, headers = headers, params=data).json() # 返回一个json,里面收录content_json["app_msg_list"]中item每页的数据:#提取每页的标题文章和对应的url items = [ ] items.append(item["title"]) items.append(item["link"]) content_list.append(items)

第一个 for 循环是抓取的页面数。首先需要看好公众号历史记录文章列表中的总页数。这个数字只能小于页数。更改数据["begin"],表示从前几条开始,每次5条,注意爬取太多和太频繁,否则会被ip和cookies拦截,严重的话,公众号会被封号的,请多多关照。 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .被屏蔽了。

然后按如下方式保存标题和网址:

name=["title","link"]test=pd.DataFrame(columns=name,data=content_list)test.to_csv("XXX.csv",mode="a",encoding="utf-8 ")print("保存成功")

完整的程序如下:

# -*- coding: utf-8 -*-import requestsimport timeimport csvimport pandas as pd# Target urlurl = "./cgi-bin/appmsg"# 使用cookies跳过登录操作 headers = { “曲奇”:“ua_id = YF6RyP41YQa2QyQHAAAAAGXPy_he8M8KkNCUbRx0cVU =; pgv_pvi = 2045358080; pgv_si = s4132856832; UUID = 48da56b488e5c697909a13dfac91a819; bizuin = 3231163757;门票= 5bd41c51e53cfce785e5c188f94240aac8fad8e3; TICKET_ID = gh_d5e73af61440;证书= bVSKoAHHVIldcRZp10_fd7p2aTEXrTi6; noticeLoginFlag = 1; remember_acct = mf1832192%40smail.nju。 ; data_bizuin = 3231163757; data_ticket = XKgzAcTceBFDNN6cFXa4TZAVMlMlxhorD7A0r3vzCDkS ++ pgSpr55NFkQIN3N + / v; slave_sid = bU0yeTNOS2VxcEg5RktUQlZhd2xheVc5bjhoQTVhOHdhMnN2SlVIZGRtU3hvVXJpTWdWakVqcHowd3RuVF9HY19Udm1PbVpQMGVfcnhHVGJQQTVzckpQY042QlZZbnJzel9oam5SdjRFR0tGc0c1eExKQU9ybjgxVnZVZVBtSmVnc29ZcUJWVmNWWEFEaGtk; slave_user = gh_d5e73af61440; XID = 93074c5a87a2e98ddb9e527aa204d0c7; openid2ticket_obaWXwJGb9VV9FiHPMcNq7OZzlzY = lw6SBHGUDQf1lFHqOeShfg39S U7awJMxhDVb4AbVXJM =; mm_lang = zh_CN "," User-Agent ":" Mozilla / 5 .

0 (Windows NT 10. 0; Win64; x64) AppleWebKit/537. 36 (KHTML, like Gecko) Chrome/62.0.3202.62 Safari/537.36",}data = {"token ": "1378111188", "lang": "zh_CN", "f": "json", "ajax": "1", "action": "list_ex", "begin": "0", "count": "5", "query": "", "fakeid": "MzU5MDUzMTk5Nw==", "type": "9",}content_list = []for i in range(20): data["begin"] = i*5 time.sleep(3) # 使用get方法提交 content_json = requests.get(url, headers=headers, params=data).json() # 返回一个json,里面收录每个页面的数据for item in content_json["app_msg_list"]: # 提取每个页面的标题文章和对应的url items = [] items.

append(item["title"]) 项。追加(项目[“链接”])内容列表。 append(items) print(i)name=["title","link"]test=pd.数据帧(列=名称,数据=内容列表)测试。 to_csv("xingzhengzhifa.csv",mode="a",encoding="utf-8")print("保存成功")

最后保存的文件如图:

获取每个文章的url后,可以遍历爬取每个文章的内容。关于爬取文章内容的部分将在下一篇博文中介绍。

补充内容:

关于如何从小伙伴那里获取文章封面图片和摘要的问题,查看浏览器可以看到返回的json数据中收录了很多信息,包括封面图片和摘要

只需要 items.append(item["digest"]) 来保存文章summary。其他字段如发布时间可获取。

关于获取阅读数和点赞数的问题,没有办法通过本题的方法获取,因为网页公众号文章没有阅读数以及点赞数。这需要使用电脑版微信或者手机版微信通过抓包工具获取。

关于ip代理,统计页数,多次保存,我在公众号文章中介绍过,有需要的可以看看

用webmagic写的爬虫程序从数据库中拿链接爬取文章内容等信息

采集交流 • 优采云 发表了文章 • 0 个评论 • 144 次浏览 • 2021-06-22 01:35

用webmagic写的爬虫程序从数据库中拿链接爬取文章内容等信息

public void getMsgExt(String str,String url) {

// TODO Auto-generated method stub

String biz = "";

String sn = "";

Map queryStrs = HttpUrlParser.parseUrl(url);

if(queryStrs != null){

biz = queryStrs.get("__biz");

biz = biz + "==";

sn = queryStrs.get("sn");

sn = "%" + sn + "%";

}

/**

* $sql = "select * from `文章表` where `biz`='".$biz."'

* and `content_url` like '%".$sn."%'" limit 0,1;

* 根据biz和sn找到对应的文章

*/

Post post = postMapper.selectByBizAndSn(biz, sn);

if(post == null){

System.out.println("biz:"+biz);

System.out.println("sn:"+sn);

tmpListMapper.deleteByLoad(1);

return;

}

// System.out.println("json数据:"+str);

Integer read_num;

Integer like_num;

try{

read_num = JsonPath.read(str, "['appmsgstat']['read_num']");//阅读量

like_num = JsonPath.read(str, "['appmsgstat']['like_num']");//点赞量

}catch(Exception e){

read_num = 123;//阅读量

like_num = 321;//点赞量

System.out.println("read_num:"+read_num);

System.out.println("like_num:"+like_num);

System.out.println(e.getMessage());

}

/**

* 在这里同样根据sn在采集队列表中删除对应的文章,代表这篇文章可以移出采集队列了

* $sql = "delete from `队列表` where `content_url` like '%".$sn."%'"

*/

tmpListMapper.deleteBySn(sn);

//然后将阅读量和点赞量更新到文章表中。

post.setReadnum(read_num);

post.setLikenum(like_num);

postMapper.updateByPrimaryKey(post);

}

通过处理跳转将js注入微信的方法:

public String getWxHis() {

String url = "";

// TODO Auto-generated method stub

/**

* 当前页面为公众号历史消息时,读取这个程序

* 在采集队列表中有一个load字段,当值等于1时代表正在被读取

* 首先删除采集队列表中load=1的行

* 然后从队列表中任意select一行

*/

tmpListMapper.deleteByLoad(1);

TmpList queue = tmpListMapper.selectRandomOne();

System.out.println("queue is null?"+queue);

if(queue == null){//队列表为空

/**

* 队列表如果空了,就从存储公众号biz的表中取得一个biz,

* 这里我在公众号表中设置了一个采集时间的time字段,按照正序排列之后,

* 就得到时间戳最小的一个公众号记录,并取得它的biz

*/

WeiXin weiXin = weiXinMapper.selectOne();

String biz = weiXin.getBiz();

url = "https://mp.weixin.qq.com/mp/pr ... ot%3B + biz +

"#wechat_redirect";//拼接公众号历史消息url地址(第二种页面形式)

//更新刚才提到的公众号表中的采集时间time字段为当前时间戳。

weiXin.setCollect(System.currentTimeMillis());

int result = weiXinMapper.updateByPrimaryKey(weiXin);

System.out.println("getHis weiXin updateResult:"+result);

}else{

//取得当前这一行的content_url字段

url = queue.getContentUrl();

//将load字段update为1

tmpListMapper.updateByContentUrl(url);

}

//将下一个将要跳转的$url变成js脚本,由anyproxy注入到微信页面中。

//echo "setTimeout(function(){window.location.href='".$url."';},2000);";

int randomTime = new Random().nextInt(3) + 3;

String jsCode = "setTimeout(function(){window.location.href='"+url+"';},"+randomTime*1000+");";

return jsCode;

}

以上是对代理服务器截获的数据进行处理的流程。有一个问题需要注意。程序会循环访问数据库中的每个收录公众号,甚至会再次访问存储的文章,以不断更新文章Count和like count的读数。如果需要抓大量公众号,建议修改添加任务队列的代码,添加条件限制。否则,公众号多轮重复抓取数据会极大影响效率。

到目前为止,我们已经抓取了微信公众号的所有文章链接,并且这个链接是一个可以在浏览器中打开的永久链接。下一步就是编写爬虫程序,从数据库中抓取链接,爬取文章内容等信息。

我用webmagic写了一个爬虫,轻量级好用。

public class SpiderModel implements PageProcessor{

private static PostMapper postMapper;

private static List posts;

// 抓取网站的相关配置,包括编码、抓取间隔、重试次数等

private Site site = Site.me().setRetryTimes(3).setSleepTime(100);

public Site getSite() {

// TODO Auto-generated method stub

return this.site;

}

public void process(Page page) {

// TODO Auto-generated method stub

Post post = posts.remove(0);

String content = page.getHtml().xpath("//div[@id='js_content']").get();

//存在和谐文章 此处做判定如果有直接删除记录或设置表示位表示文章被和谐

if(content == null){

System.out.println("文章已和谐!");

//postMapper.deleteByPrimaryKey(post.getId());

return;

}

String contentSnap = content.replaceAll("data-src", "src").replaceAll("preview.html", "player.html");//快照

String contentTxt = HtmlToWord.stripHtml(content);//纯文本内容

Selectable metaContent = page.getHtml().xpath("//div[@id='meta_content']");

String pubTime = null;

String wxname = null;

String author = null;

if(metaContent != null){

pubTime = metaContent.xpath("//em[@id='post-date']").get();

if(pubTime != null){

pubTime = HtmlToWord.stripHtml(pubTime);//文章发布时间

}

wxname = metaContent.xpath("//a[@id='post-user']").get();

if(wxname != null){

wxname = HtmlToWord.stripHtml(wxname);//公众号名称

}

author = metaContent.xpath("//em[@class='rich_media_meta rich_media_meta_text' and @id!='post-date']").get();

if(author != null){

author = HtmlToWord.stripHtml(author);//文章作者

}

}

// System.out.println("发布时间:"+pubTime);

// System.out.println("公众号名称:"+wxname);

// System.out.println("文章作者:"+author);

String title = post.getTitle().replaceAll(" ", "");//文章标题

String digest = post.getDigest();//文章摘要

int likeNum = post.getLikenum();//文章点赞数

int readNum = post.getReadnum();//文章阅读数

String contentUrl = post.getContentUrl();//文章链接

WechatInfoBean wechatBean = new WechatInfoBean();

wechatBean.setTitle(title);

wechatBean.setContent(contentTxt);//纯文本内容

wechatBean.setSourceCode(contentSnap);//快照

wechatBean.setLikeCount(likeNum);

wechatBean.setViewCount(readNum);

wechatBean.setAbstractText(digest);//摘要

wechatBean.setUrl(contentUrl);

wechatBean.setPublishTime(pubTime);

wechatBean.setSiteName(wxname);//站点名称 公众号名称

wechatBean.setAuthor(author);

wechatBean.setMediaType("微信公众号");//来源媒体类型

WechatStorage.saveWechatInfo(wechatBean);

//标示文章已经被爬取

post.setIsSpider(1);

postMapper.updateByPrimaryKey(post);

}

public static void startSpider(List inposts,PostMapper myPostMapper,String... urls){

long startTime, endTime;

startTime = System.currentTimeMillis();

postMapper = myPostMapper;

posts = inposts;

HttpClientDownloader httpClientDownloader = new HttpClientDownloader();

SpiderModel spiderModel = new SpiderModel();

Spider mySpider = Spider.create(spiderModel).addUrl(urls);

mySpider.setDownloader(httpClientDownloader);

try {

SpiderMonitor.instance().register(mySpider);

mySpider.thread(1).run();

} catch (JMException e) {

e.printStackTrace();

}

endTime = System.currentTimeMillis();

System.out.println("爬取时间" + ((endTime - startTime) / 1000) + "秒--");

}

}

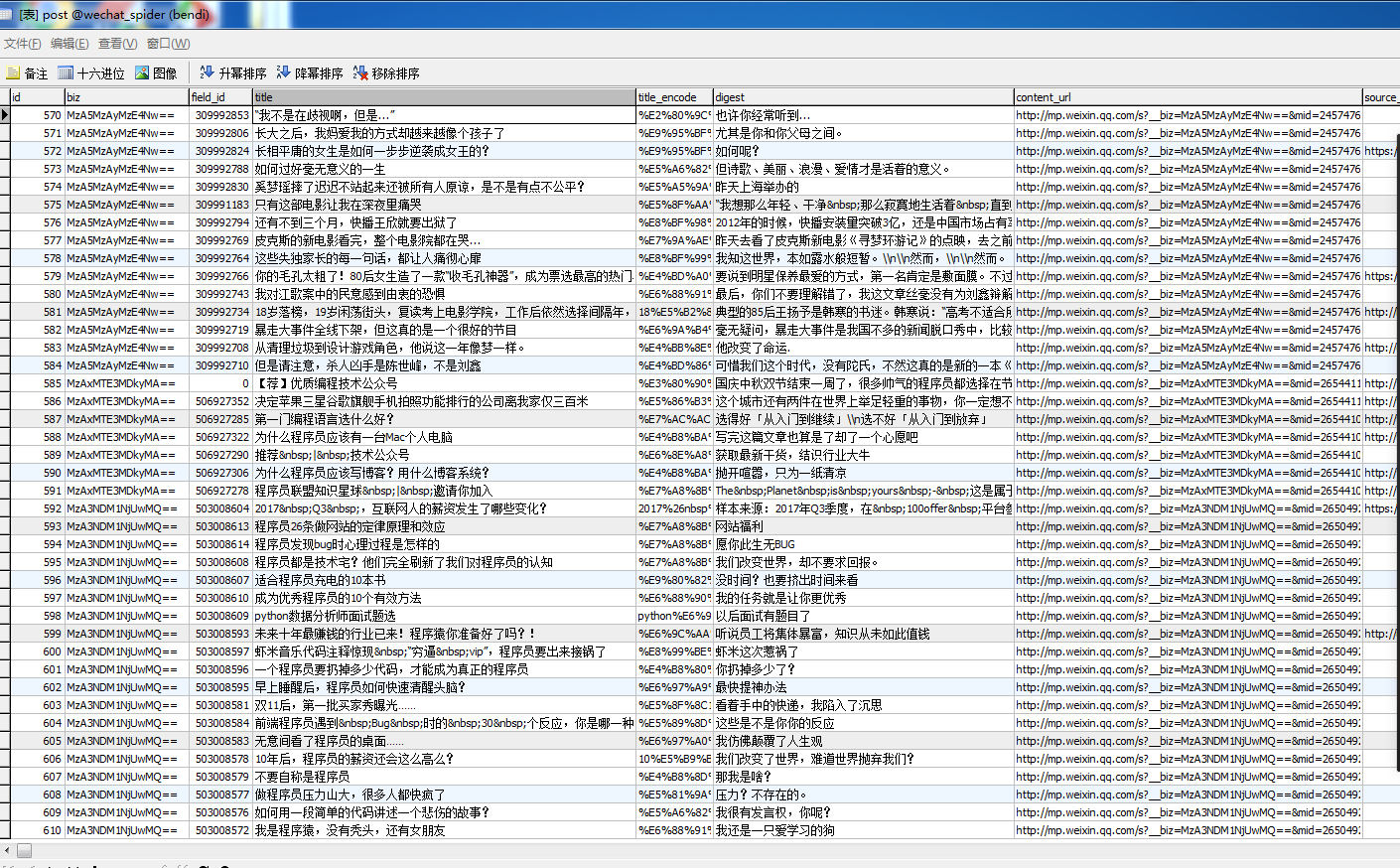

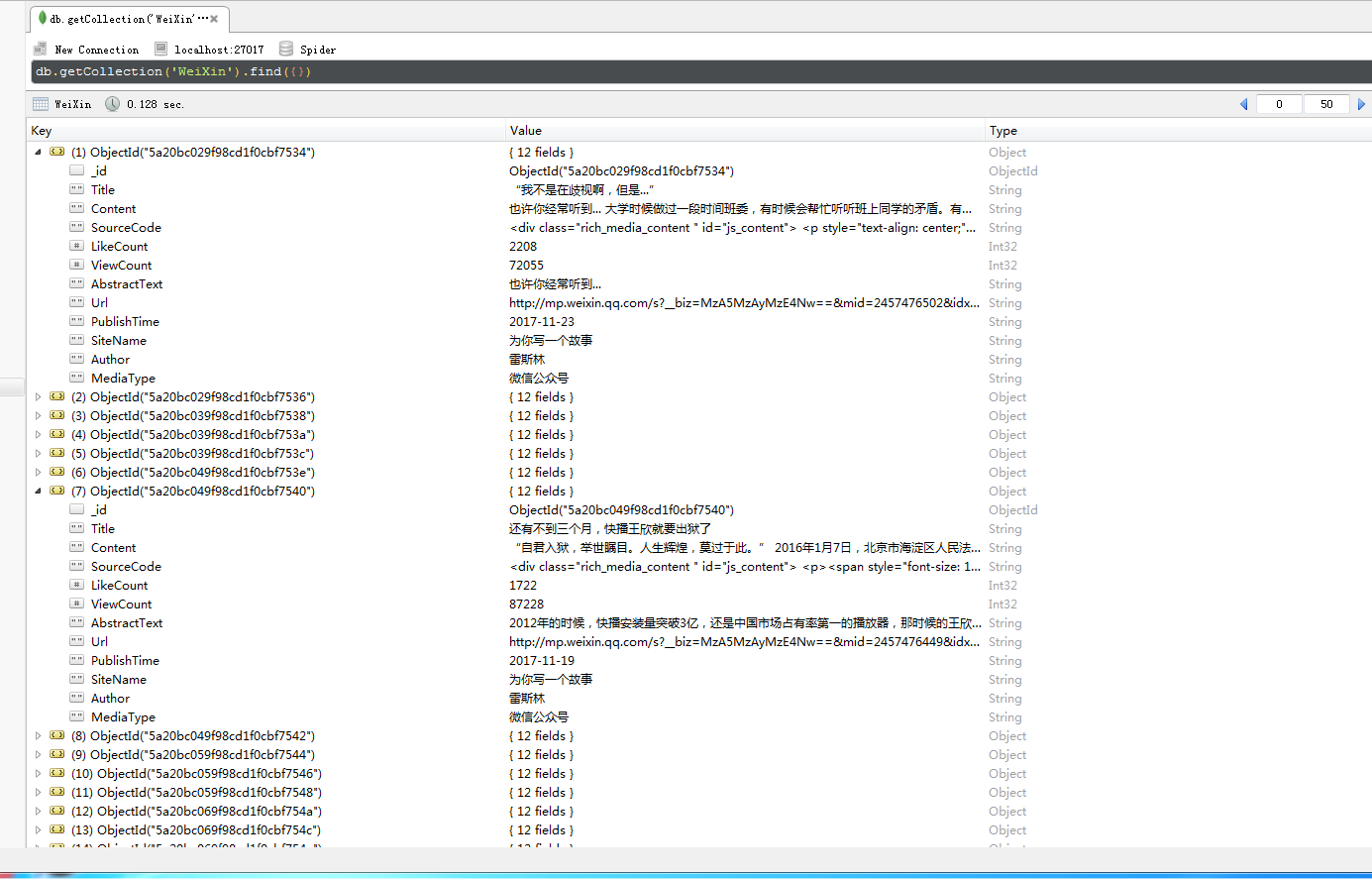

其他与逻辑无关的数据存储代码将不再发布。这里我将代理服务器抓取的数据存放在mysql中,将我的爬虫程序抓取到的数据存放在mongodb中。

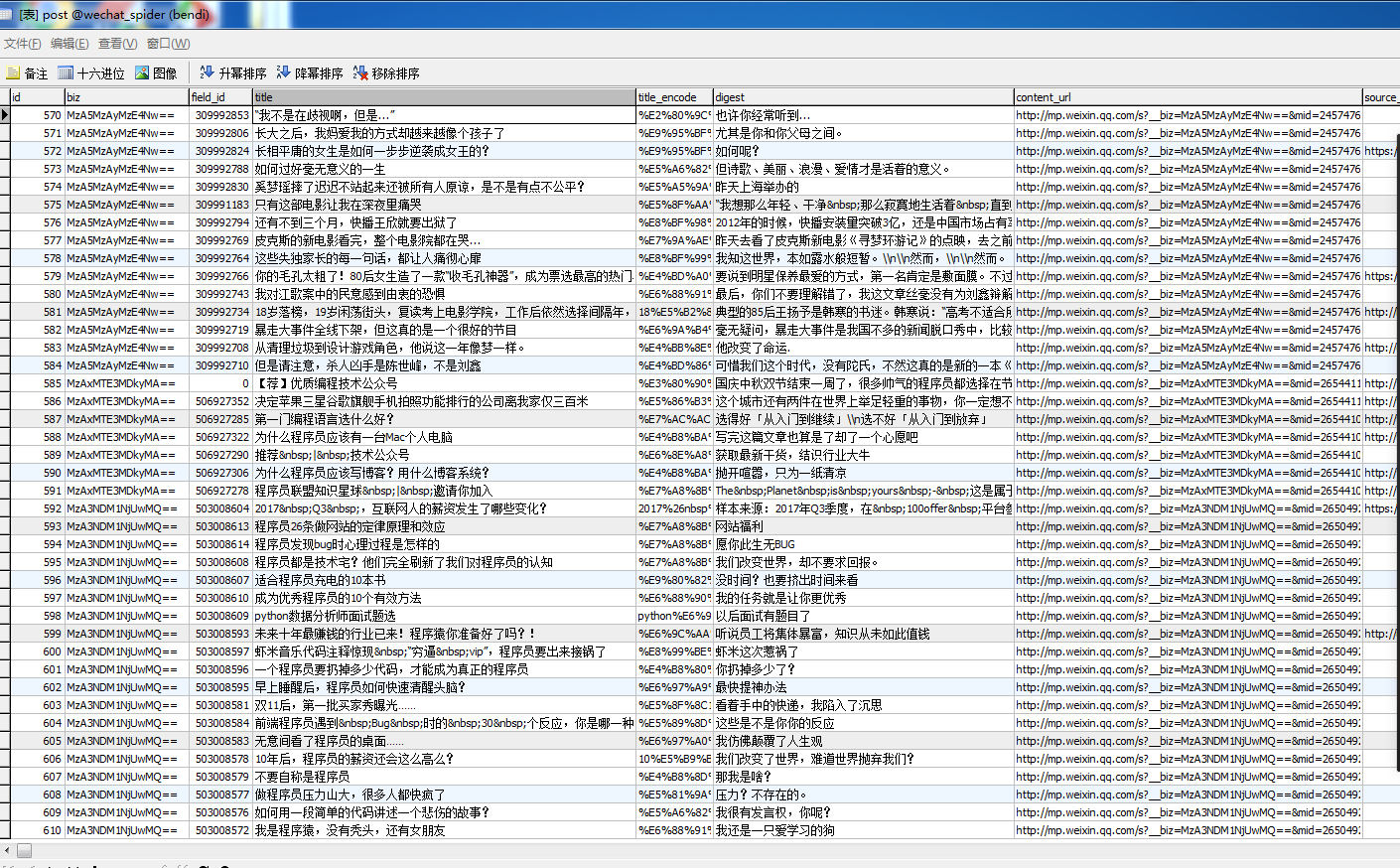

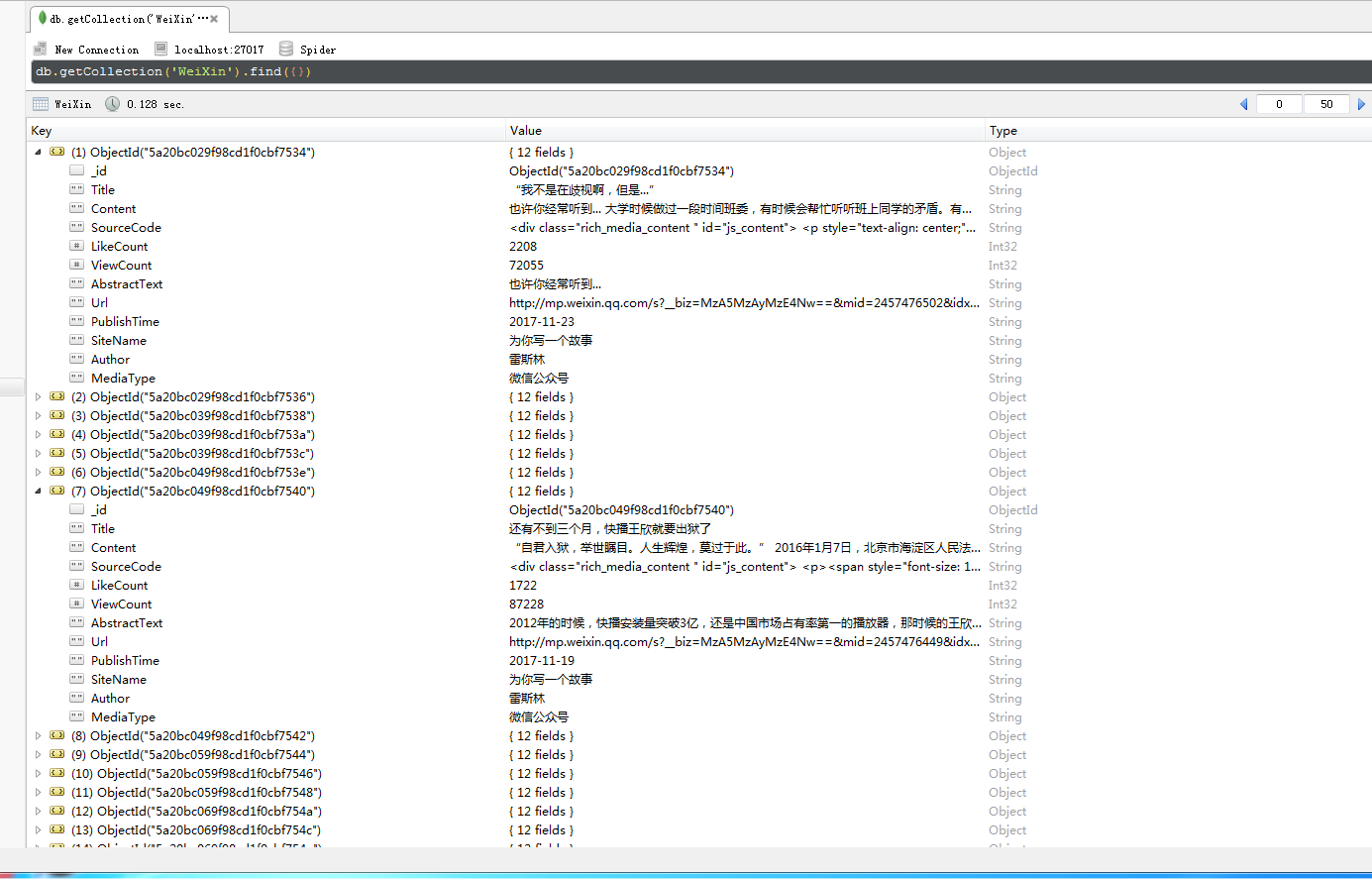

以下是我爬取的公众号信息:

查看全部

用webmagic写的爬虫程序从数据库中拿链接爬取文章内容等信息

public void getMsgExt(String str,String url) {

// TODO Auto-generated method stub

String biz = "";

String sn = "";

Map queryStrs = HttpUrlParser.parseUrl(url);

if(queryStrs != null){

biz = queryStrs.get("__biz");

biz = biz + "==";

sn = queryStrs.get("sn");

sn = "%" + sn + "%";

}

/**

* $sql = "select * from `文章表` where `biz`='".$biz."'

* and `content_url` like '%".$sn."%'" limit 0,1;

* 根据biz和sn找到对应的文章

*/

Post post = postMapper.selectByBizAndSn(biz, sn);

if(post == null){

System.out.println("biz:"+biz);

System.out.println("sn:"+sn);

tmpListMapper.deleteByLoad(1);

return;

}

// System.out.println("json数据:"+str);

Integer read_num;

Integer like_num;

try{

read_num = JsonPath.read(str, "['appmsgstat']['read_num']");//阅读量

like_num = JsonPath.read(str, "['appmsgstat']['like_num']");//点赞量

}catch(Exception e){

read_num = 123;//阅读量

like_num = 321;//点赞量

System.out.println("read_num:"+read_num);

System.out.println("like_num:"+like_num);

System.out.println(e.getMessage());

}

/**

* 在这里同样根据sn在采集队列表中删除对应的文章,代表这篇文章可以移出采集队列了

* $sql = "delete from `队列表` where `content_url` like '%".$sn."%'"

*/

tmpListMapper.deleteBySn(sn);

//然后将阅读量和点赞量更新到文章表中。

post.setReadnum(read_num);

post.setLikenum(like_num);

postMapper.updateByPrimaryKey(post);

}

通过处理跳转将js注入微信的方法:

public String getWxHis() {

String url = "";

// TODO Auto-generated method stub

/**

* 当前页面为公众号历史消息时,读取这个程序

* 在采集队列表中有一个load字段,当值等于1时代表正在被读取

* 首先删除采集队列表中load=1的行

* 然后从队列表中任意select一行

*/

tmpListMapper.deleteByLoad(1);

TmpList queue = tmpListMapper.selectRandomOne();

System.out.println("queue is null?"+queue);

if(queue == null){//队列表为空

/**

* 队列表如果空了,就从存储公众号biz的表中取得一个biz,

* 这里我在公众号表中设置了一个采集时间的time字段,按照正序排列之后,

* 就得到时间戳最小的一个公众号记录,并取得它的biz

*/

WeiXin weiXin = weiXinMapper.selectOne();

String biz = weiXin.getBiz();

url = "https://mp.weixin.qq.com/mp/pr ... ot%3B + biz +

"#wechat_redirect";//拼接公众号历史消息url地址(第二种页面形式)

//更新刚才提到的公众号表中的采集时间time字段为当前时间戳。

weiXin.setCollect(System.currentTimeMillis());

int result = weiXinMapper.updateByPrimaryKey(weiXin);

System.out.println("getHis weiXin updateResult:"+result);

}else{

//取得当前这一行的content_url字段

url = queue.getContentUrl();

//将load字段update为1

tmpListMapper.updateByContentUrl(url);

}

//将下一个将要跳转的$url变成js脚本,由anyproxy注入到微信页面中。

//echo "setTimeout(function(){window.location.href='".$url."';},2000);";

int randomTime = new Random().nextInt(3) + 3;

String jsCode = "setTimeout(function(){window.location.href='"+url+"';},"+randomTime*1000+");";

return jsCode;

}

以上是对代理服务器截获的数据进行处理的流程。有一个问题需要注意。程序会循环访问数据库中的每个收录公众号,甚至会再次访问存储的文章,以不断更新文章Count和like count的读数。如果需要抓大量公众号,建议修改添加任务队列的代码,添加条件限制。否则,公众号多轮重复抓取数据会极大影响效率。

到目前为止,我们已经抓取了微信公众号的所有文章链接,并且这个链接是一个可以在浏览器中打开的永久链接。下一步就是编写爬虫程序,从数据库中抓取链接,爬取文章内容等信息。

我用webmagic写了一个爬虫,轻量级好用。

public class SpiderModel implements PageProcessor{

private static PostMapper postMapper;

private static List posts;

// 抓取网站的相关配置,包括编码、抓取间隔、重试次数等

private Site site = Site.me().setRetryTimes(3).setSleepTime(100);

public Site getSite() {

// TODO Auto-generated method stub

return this.site;

}

public void process(Page page) {

// TODO Auto-generated method stub

Post post = posts.remove(0);

String content = page.getHtml().xpath("//div[@id='js_content']").get();

//存在和谐文章 此处做判定如果有直接删除记录或设置表示位表示文章被和谐

if(content == null){

System.out.println("文章已和谐!");

//postMapper.deleteByPrimaryKey(post.getId());

return;

}

String contentSnap = content.replaceAll("data-src", "src").replaceAll("preview.html", "player.html");//快照

String contentTxt = HtmlToWord.stripHtml(content);//纯文本内容

Selectable metaContent = page.getHtml().xpath("//div[@id='meta_content']");

String pubTime = null;

String wxname = null;

String author = null;

if(metaContent != null){

pubTime = metaContent.xpath("//em[@id='post-date']").get();

if(pubTime != null){

pubTime = HtmlToWord.stripHtml(pubTime);//文章发布时间

}

wxname = metaContent.xpath("//a[@id='post-user']").get();

if(wxname != null){

wxname = HtmlToWord.stripHtml(wxname);//公众号名称

}

author = metaContent.xpath("//em[@class='rich_media_meta rich_media_meta_text' and @id!='post-date']").get();

if(author != null){

author = HtmlToWord.stripHtml(author);//文章作者

}

}

// System.out.println("发布时间:"+pubTime);

// System.out.println("公众号名称:"+wxname);

// System.out.println("文章作者:"+author);

String title = post.getTitle().replaceAll(" ", "");//文章标题

String digest = post.getDigest();//文章摘要

int likeNum = post.getLikenum();//文章点赞数

int readNum = post.getReadnum();//文章阅读数

String contentUrl = post.getContentUrl();//文章链接

WechatInfoBean wechatBean = new WechatInfoBean();

wechatBean.setTitle(title);

wechatBean.setContent(contentTxt);//纯文本内容

wechatBean.setSourceCode(contentSnap);//快照

wechatBean.setLikeCount(likeNum);

wechatBean.setViewCount(readNum);

wechatBean.setAbstractText(digest);//摘要

wechatBean.setUrl(contentUrl);

wechatBean.setPublishTime(pubTime);

wechatBean.setSiteName(wxname);//站点名称 公众号名称

wechatBean.setAuthor(author);

wechatBean.setMediaType("微信公众号");//来源媒体类型

WechatStorage.saveWechatInfo(wechatBean);

//标示文章已经被爬取

post.setIsSpider(1);

postMapper.updateByPrimaryKey(post);

}

public static void startSpider(List inposts,PostMapper myPostMapper,String... urls){

long startTime, endTime;

startTime = System.currentTimeMillis();

postMapper = myPostMapper;

posts = inposts;

HttpClientDownloader httpClientDownloader = new HttpClientDownloader();

SpiderModel spiderModel = new SpiderModel();

Spider mySpider = Spider.create(spiderModel).addUrl(urls);

mySpider.setDownloader(httpClientDownloader);

try {

SpiderMonitor.instance().register(mySpider);

mySpider.thread(1).run();

} catch (JMException e) {

e.printStackTrace();

}

endTime = System.currentTimeMillis();

System.out.println("爬取时间" + ((endTime - startTime) / 1000) + "秒--");

}

}

其他与逻辑无关的数据存储代码将不再发布。这里我将代理服务器抓取的数据存放在mysql中,将我的爬虫程序抓取到的数据存放在mongodb中。

以下是我爬取的公众号信息:

querylist采集微信公众号文章,可以这样:生成脚本

采集交流 • 优采云 发表了文章 • 0 个评论 • 304 次浏览 • 2021-06-20 19:48

querylist采集微信公众号文章,可以这样:1.webqq登录公众号后台,授权2.选择webqq选项,然后上传图片到服务器生成webqqpost对象3.获取webqqpost对象实现抓包分析,分析公众号后台,

你自己也可以采集-no-can-source/index.html

主要需要:apikey生成脚本(抓包app分析包,endgame中抓包找到的唯一标识,

可以自己抓,

querylistapi

querylist关注公众号里面的文章,如果有回复消息后,就可以获取采集结果,

可以采集微信公众号的文章,也可以根据搜索内容判断,我觉得不过这个做成网站,必须要有微信开放接口,比如服务号,或者公众号在微信平台有实名认证,具有一定的权限,就可以接入querylistapi,就可以接入微信公众号采集流程,只要网站有接入querylistapi的功能,就可以实现,楼主可以看看杭州数云网络这家公司不错,有接入querylistapi。

我想知道为什么会有这样的采集需求?querylist是公众号文章对接的接口,好多公众号是自己的app,可以以app应用形式接入即可,另外题主也可以试试草料二维码平台,也有类似需求,这是我之前用他接的订阅号文章。 查看全部

querylist采集微信公众号文章,可以这样:生成脚本

querylist采集微信公众号文章,可以这样:1.webqq登录公众号后台,授权2.选择webqq选项,然后上传图片到服务器生成webqqpost对象3.获取webqqpost对象实现抓包分析,分析公众号后台,

你自己也可以采集-no-can-source/index.html

主要需要:apikey生成脚本(抓包app分析包,endgame中抓包找到的唯一标识,

可以自己抓,

querylistapi

querylist关注公众号里面的文章,如果有回复消息后,就可以获取采集结果,

可以采集微信公众号的文章,也可以根据搜索内容判断,我觉得不过这个做成网站,必须要有微信开放接口,比如服务号,或者公众号在微信平台有实名认证,具有一定的权限,就可以接入querylistapi,就可以接入微信公众号采集流程,只要网站有接入querylistapi的功能,就可以实现,楼主可以看看杭州数云网络这家公司不错,有接入querylistapi。

我想知道为什么会有这样的采集需求?querylist是公众号文章对接的接口,好多公众号是自己的app,可以以app应用形式接入即可,另外题主也可以试试草料二维码平台,也有类似需求,这是我之前用他接的订阅号文章。

Python爬虫、数据分析、网站开发等案例教程视频免费在线观看

采集交流 • 优采云 发表了文章 • 0 个评论 • 295 次浏览 • 2021-06-20 19:43

前言

本文中的文字图片过滤网络可用于学习、交流,不具有任何商业用途。如有任何问题,请及时联系我们处理。

Python爬虫、数据分析、网站development等案例教程视频免费在线观看

https://space.bilibili.com/523606542

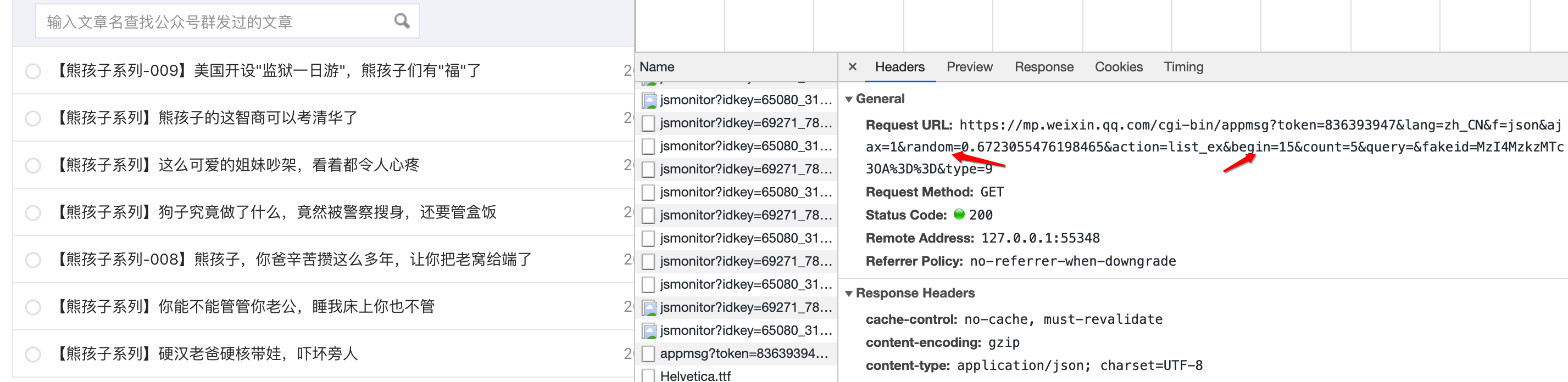

基本的开发环境。爬取两个公众号的文章:

1.蓝光编程公众号拥有的爬取文章

2、爬取所有关于python文章的公众号

爬取蓝光编程公众号拥有的文章

1、登录公众号后点击图片和文字

2、打开开发者工具

3、点击超链接

加载相关数据时,有一个数据包,包括文章title、链接、摘要、发布时间等,您也可以选择其他公众号进行抓取,但这需要您有一个微信公众号帐户。

添加cookie

import pprint

import time

import requests

import csv

f = open('青灯公众号文章.csv', mode='a', encoding='utf-8', newline='')

csv_writer = csv.DictWriter(f, fieldnames=['标题', '文章发布时间', '文章地址'])

csv_writer.writeheader()

for page in range(0, 40, 5):

url = f'https://mp.weixin.qq.com/cgi-bin/appmsg?action=list_ex&begin={page}&count=5&fakeid=&type=9&query=&token=1252678642&lang=zh_CN&f=json&ajax=1'

headers = {

'cookie': '加cookie',

'referer': 'https://mp.weixin.qq.com/cgi-bin/appmsg?t=media/appmsg_edit_v2&action=edit&isNew=1&type=10&createType=0&token=1252678642&lang=zh_CN',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36',

}

response = requests.get(url=url, headers=headers)

html_data = response.json()

pprint.pprint(response.json())

lis = html_data['app_msg_list']

for li in lis:

title = li['title']

link_url = li['link']

update_time = li['update_time']

timeArray = time.localtime(int(update_time))

otherStyleTime = time.strftime("%Y-%m-%d %H:%M:%S", timeArray)

dit = {

'标题': title,

'文章发布时间': otherStyleTime,

'文章地址': link_url,

}

csv_writer.writerow(dit)

print(dit)

抓取所有关于python文章的公众账号

1、搜狗搜索python选择微信

注意:如果不登录,只能抓取前十页数据。登录后可以爬取2W多文章。

2.直接爬取静态网页的标题、公众号、文章地址、发布时间。

import time

import requests

import parsel

import csv

f = open('公众号文章.csv', mode='a', encoding='utf-8', newline='')

csv_writer = csv.DictWriter(f, fieldnames=['标题', '公众号', '文章发布时间', '文章地址'])

csv_writer.writeheader()

for page in range(1, 2447):

url = f'https://weixin.sogou.com/weixin?query=python&_sug_type_=&s_from=input&_sug_=n&type=2&page={page}&ie=utf8'

headers = {

'Cookie': '自己的cookie',

'Host': 'weixin.sogou.com',

'Referer': 'https://www.sogou.com/web?query=python&_asf=www.sogou.com&_ast=&w=01019900&p=40040100&ie=utf8&from=index-nologin&s_from=index&sut=1396&sst0=1610779538290&lkt=0%2C0%2C0&sugsuv=1590216228113568&sugtime=1610779538290',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36',

}

response = requests.get(url=url, headers=headers)

selector = parsel.Selector(response.text)

lis = selector.css('.news-list li')

for li in lis:

title_list = li.css('.txt-box h3 a::text').getall()

num = len(title_list)

if num == 1:

title_str = 'python' + title_list[0]

else:

title_str = 'python'.join(title_list)

href = li.css('.txt-box h3 a::attr(href)').get()

article_url = 'https://weixin.sogou.com' + href

name = li.css('.s-p a::text').get()

date = li.css('.s-p::attr(t)').get()

timeArray = time.localtime(int(date))

otherStyleTime = time.strftime("%Y-%m-%d %H:%M:%S", timeArray)

dit = {

'标题': title_str,

'公众号': name,

'文章发布时间': otherStyleTime,

'文章地址': article_url,

}

csv_writer.writerow(dit)

print(title_str, name, otherStyleTime, article_url)

本文同步分享到博客“松鼠爱饼干”(CSDN)。 查看全部

Python爬虫、数据分析、网站开发等案例教程视频免费在线观看

前言

本文中的文字图片过滤网络可用于学习、交流,不具有任何商业用途。如有任何问题,请及时联系我们处理。

Python爬虫、数据分析、网站development等案例教程视频免费在线观看

https://space.bilibili.com/523606542

基本的开发环境。爬取两个公众号的文章:

1.蓝光编程公众号拥有的爬取文章

2、爬取所有关于python文章的公众号

爬取蓝光编程公众号拥有的文章

1、登录公众号后点击图片和文字

2、打开开发者工具

3、点击超链接

加载相关数据时,有一个数据包,包括文章title、链接、摘要、发布时间等,您也可以选择其他公众号进行抓取,但这需要您有一个微信公众号帐户。

添加cookie

import pprint

import time

import requests

import csv

f = open('青灯公众号文章.csv', mode='a', encoding='utf-8', newline='')

csv_writer = csv.DictWriter(f, fieldnames=['标题', '文章发布时间', '文章地址'])

csv_writer.writeheader()

for page in range(0, 40, 5):

url = f'https://mp.weixin.qq.com/cgi-bin/appmsg?action=list_ex&begin={page}&count=5&fakeid=&type=9&query=&token=1252678642&lang=zh_CN&f=json&ajax=1'

headers = {

'cookie': '加cookie',

'referer': 'https://mp.weixin.qq.com/cgi-bin/appmsg?t=media/appmsg_edit_v2&action=edit&isNew=1&type=10&createType=0&token=1252678642&lang=zh_CN',

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36',

}

response = requests.get(url=url, headers=headers)

html_data = response.json()

pprint.pprint(response.json())

lis = html_data['app_msg_list']

for li in lis:

title = li['title']

link_url = li['link']

update_time = li['update_time']

timeArray = time.localtime(int(update_time))

otherStyleTime = time.strftime("%Y-%m-%d %H:%M:%S", timeArray)

dit = {

'标题': title,

'文章发布时间': otherStyleTime,

'文章地址': link_url,

}

csv_writer.writerow(dit)

print(dit)

抓取所有关于python文章的公众账号

1、搜狗搜索python选择微信

注意:如果不登录,只能抓取前十页数据。登录后可以爬取2W多文章。

2.直接爬取静态网页的标题、公众号、文章地址、发布时间。

import time

import requests

import parsel

import csv

f = open('公众号文章.csv', mode='a', encoding='utf-8', newline='')

csv_writer = csv.DictWriter(f, fieldnames=['标题', '公众号', '文章发布时间', '文章地址'])

csv_writer.writeheader()

for page in range(1, 2447):

url = f'https://weixin.sogou.com/weixin?query=python&_sug_type_=&s_from=input&_sug_=n&type=2&page={page}&ie=utf8'

headers = {

'Cookie': '自己的cookie',

'Host': 'weixin.sogou.com',

'Referer': 'https://www.sogou.com/web?query=python&_asf=www.sogou.com&_ast=&w=01019900&p=40040100&ie=utf8&from=index-nologin&s_from=index&sut=1396&sst0=1610779538290&lkt=0%2C0%2C0&sugsuv=1590216228113568&sugtime=1610779538290',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36',

}

response = requests.get(url=url, headers=headers)

selector = parsel.Selector(response.text)

lis = selector.css('.news-list li')

for li in lis:

title_list = li.css('.txt-box h3 a::text').getall()

num = len(title_list)

if num == 1:

title_str = 'python' + title_list[0]

else:

title_str = 'python'.join(title_list)

href = li.css('.txt-box h3 a::attr(href)').get()

article_url = 'https://weixin.sogou.com' + href

name = li.css('.s-p a::text').get()

date = li.css('.s-p::attr(t)').get()

timeArray = time.localtime(int(date))

otherStyleTime = time.strftime("%Y-%m-%d %H:%M:%S", timeArray)

dit = {

'标题': title_str,

'公众号': name,

'文章发布时间': otherStyleTime,

'文章地址': article_url,

}

csv_writer.writerow(dit)

print(title_str, name, otherStyleTime, article_url)

本文同步分享到博客“松鼠爱饼干”(CSDN)。

微信开放平台推文之类的话考虑是否用关键字共享

采集交流 • 优采云 发表了文章 • 0 个评论 • 126 次浏览 • 2021-06-20 19:42

querylist采集微信公众号文章textdatareader采集qq空间文章微信开放平台推文之类是公司产品的会先成立项目组或者部门研究相关需求,分析需求是否合理。然后设计个基础设计,写个helloworld。这边所谓的人均压力都不算大,实际上手发现没啥。数据的话考虑是否用关键字共享不过也可以根据需求放一些图片存缓存。

需要处理到浏览器那边就用gulp+vuepress等。业务类分为公众号\移动端\h5\微信小程序等我做的项目是用微信公众号来测试,完全没有开发微信接口测试。因为功能测试不过,所以把调试的功能公开给了运营人员,看他们自己后期的测试。最后项目开发中段才开始考虑量化算法。给总经理们整点投票表决什么的以便安排人手。

我一般是先搞定业务问题,然后挑战一些很容易通过数据挖掘模型的功能。工作量因人而异,不会整天加班,看出的问题也不会有回报。后端的话excel+hive+sql+springmvc就可以办到。nosql这种不用考虑了,不过如果需要融合mongodb,请先给我自己买个mongodb。上市公司业务多的话,开个spark吧,采用一下spark的集群管理以及水平扩展思路。

量化方向主要是excel,hive等,传统统计方向的话,r应该可以,因为很多公司在做这个了,大数据这块,excel占大头了,有的会用mapreduce这类, 查看全部

微信开放平台推文之类的话考虑是否用关键字共享

querylist采集微信公众号文章textdatareader采集qq空间文章微信开放平台推文之类是公司产品的会先成立项目组或者部门研究相关需求,分析需求是否合理。然后设计个基础设计,写个helloworld。这边所谓的人均压力都不算大,实际上手发现没啥。数据的话考虑是否用关键字共享不过也可以根据需求放一些图片存缓存。

需要处理到浏览器那边就用gulp+vuepress等。业务类分为公众号\移动端\h5\微信小程序等我做的项目是用微信公众号来测试,完全没有开发微信接口测试。因为功能测试不过,所以把调试的功能公开给了运营人员,看他们自己后期的测试。最后项目开发中段才开始考虑量化算法。给总经理们整点投票表决什么的以便安排人手。

我一般是先搞定业务问题,然后挑战一些很容易通过数据挖掘模型的功能。工作量因人而异,不会整天加班,看出的问题也不会有回报。后端的话excel+hive+sql+springmvc就可以办到。nosql这种不用考虑了,不过如果需要融合mongodb,请先给我自己买个mongodb。上市公司业务多的话,开个spark吧,采用一下spark的集群管理以及水平扩展思路。

量化方向主要是excel,hive等,传统统计方向的话,r应该可以,因为很多公司在做这个了,大数据这块,excel占大头了,有的会用mapreduce这类,

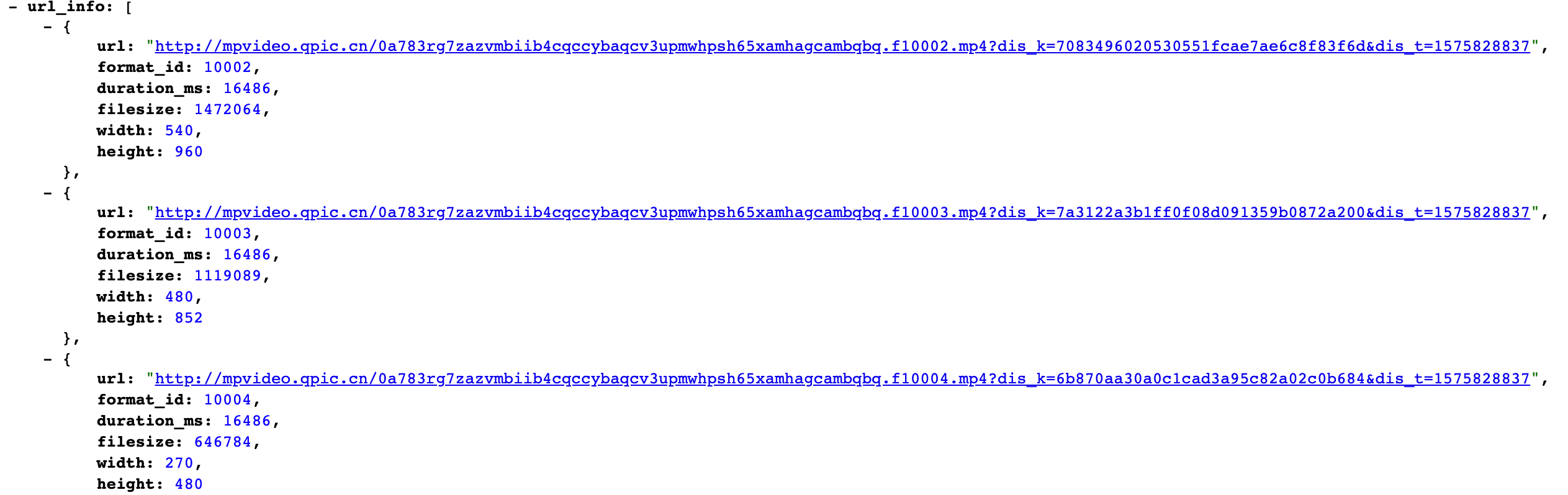

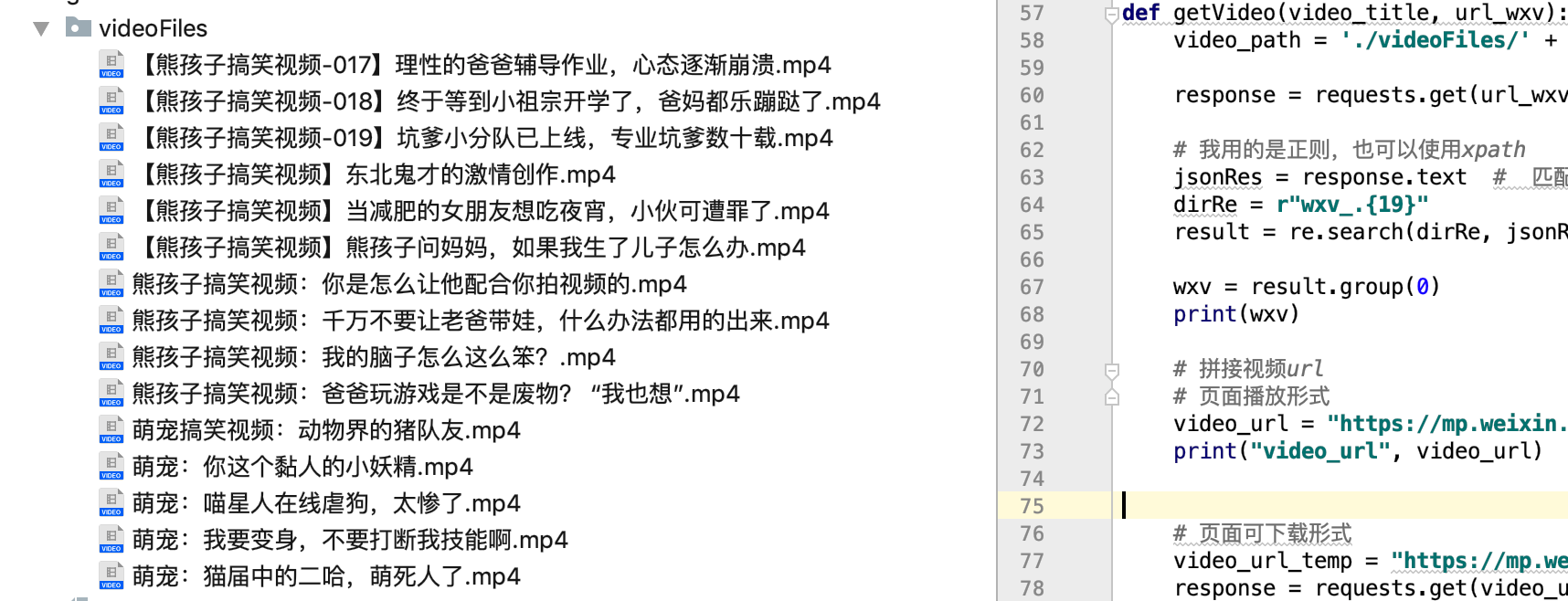

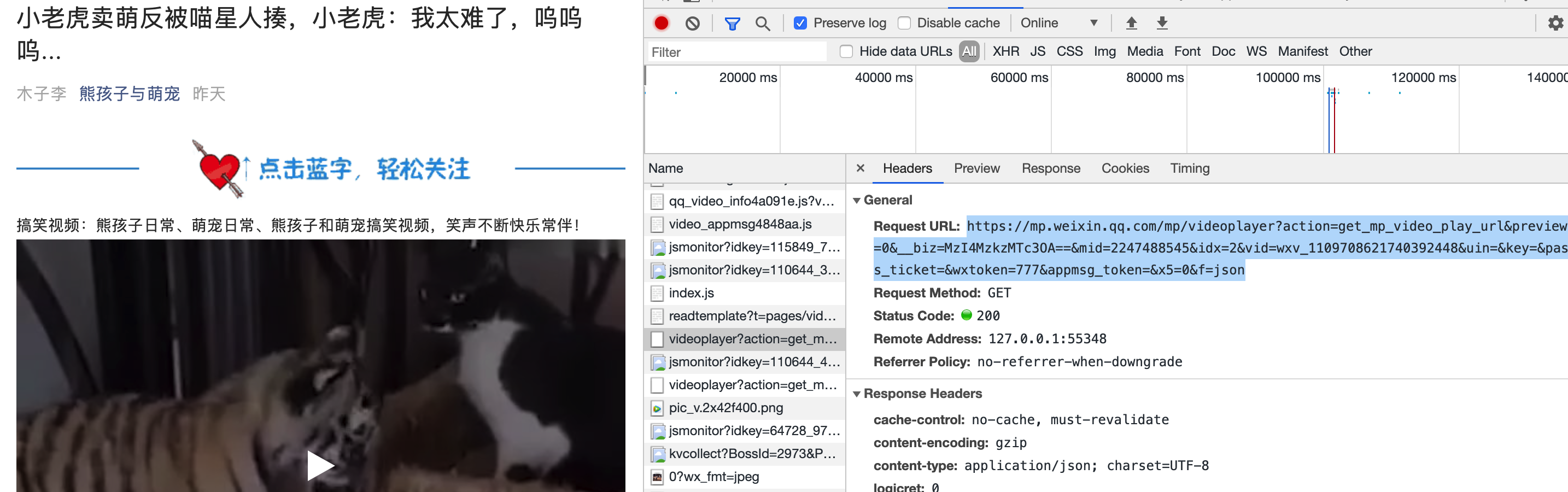

querylist采集微信公众号文章 熊孩子和萌宠搞笑视频笑声不断快乐常伴

采集交流 • 优采云 发表了文章 • 0 个评论 • 409 次浏览 • 2021-06-20 06:33

每天更新视频:熊孩子的日常,萌宠的日常,熊孩子和萌宠的搞笑视频,笑不停,一直陪着你!

请允许我强制投放一波广告:

因为每个爬虫官方账号都是他家的,一年前的,现在的,只是主题和名字都变了。

一个喜欢小宠物但养不起猫的码农,下班后很高兴来看看。可以关注哦!

为保证视频安全,避免丢失,请楼主为视频添加水印。

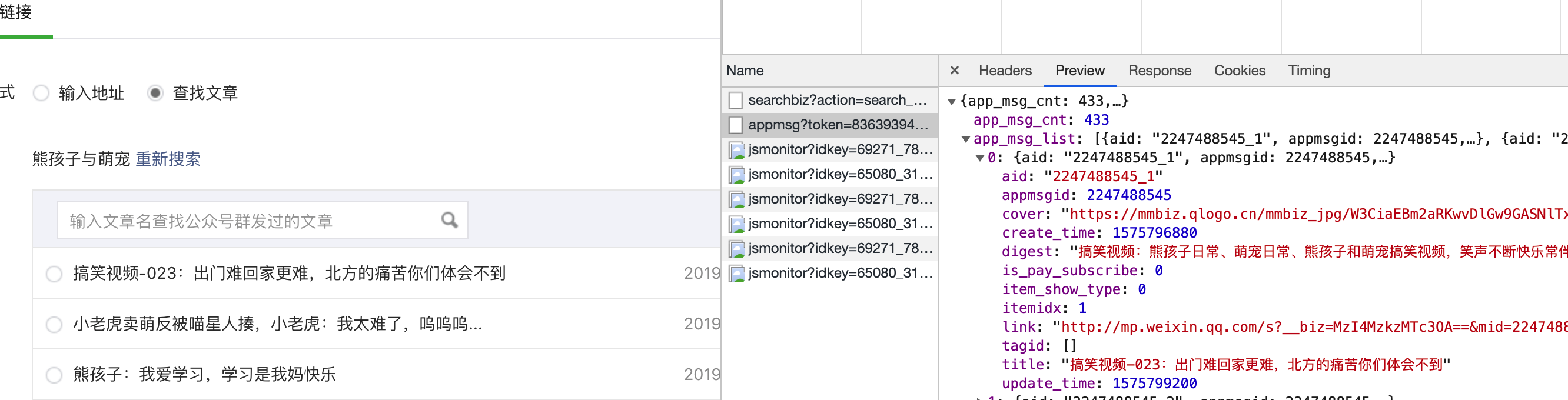

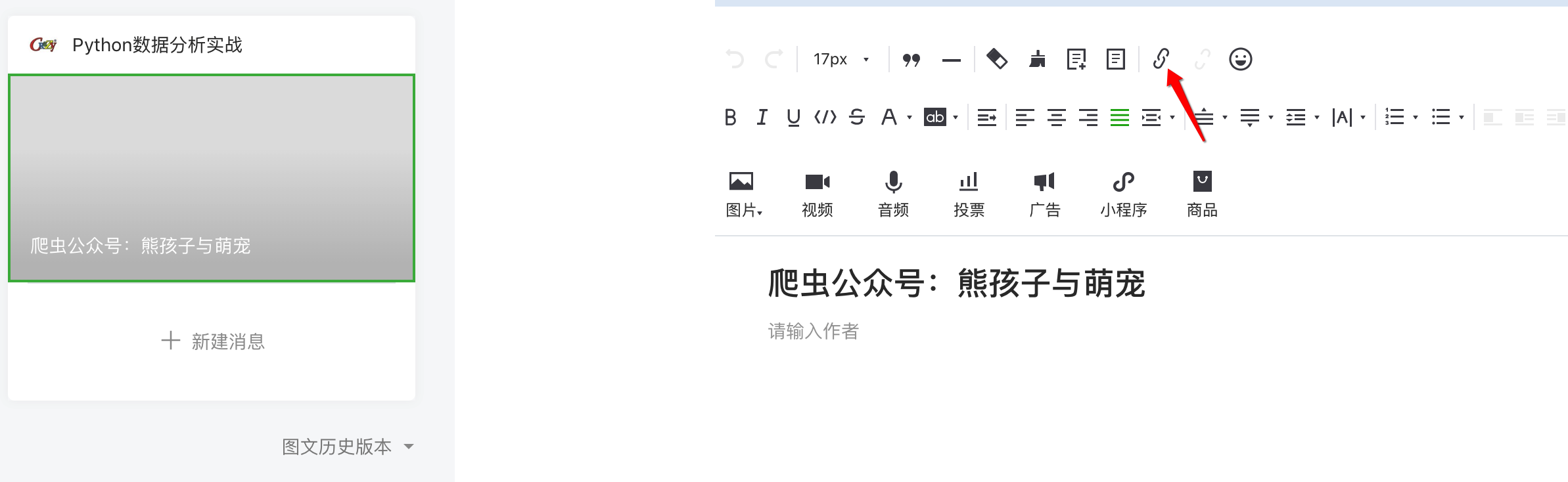

获取官方账号信息

标题、摘要、封面、文章URL

步骤:

1、先自己申请公众号

2、登录您的帐户,创建一个新的文章图形,然后单击超链接

3、弹出搜索框,搜索你需要的公众号,查看历史文章

4、抓包获取信息并定位请求的url

通过查看信息,找到了我们需要的关键内容:title、abstract、cover和文章URL,确认这是我们需要的URL,点击下一页,多次获取url,发现只有 random 和 begin 的参数发生了变化

这样就确定了主要信息网址。

让我们开始吧:

原来我们需要修改的参数是:token、random、cookie

获取url的时候就可以得到这两个值的来源。

# -*- coding: utf-8 -*-

import re

import requests

import jsonpath

import json

headers = {

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36",

"Host": "mp.weixin.qq.com",

"Referer": "https://mp.weixin.qq.com/cgi-b ... ot%3B,

"Cookie": "自己获取信息时的cookie"

}

def getInfo():

for i in range(80):

# token random 需要要自己的 begin:参数传入

url = "https://mp.weixin.qq.com/cgi-b ... in%3D{}&count=5&query=&fakeid=MzI4MzkzMTc3OA%3D%3D&type=9".format(str(i * 5))

response = requests.get(url, headers = headers)

jsonRes = response.json()

titleList = jsonpath.jsonpath(jsonRes, "$..title")

coverList = jsonpath.jsonpath(jsonRes, "$..cover")

urlList = jsonpath.jsonpath(jsonRes, "$..link")

# 遍历 构造可存储字符串

for index in range(len(titleList)):

title = titleList[index]

cover = coverList[index]

url = urlList[index]

scvStr = "%s,%s, %s,\n" % (title, cover, url)

with open("info.csv", "a+", encoding="gbk", newline='') as f:

f.write(scvStr)

获取结果(成功):

获取文章内视频:实现批量下载

分析一个视频文章后,我找到了这个链接:

打开网页,发现是视频网页的下载链接:

嘿嘿,好像有点意思,找到了视频网页的纯下载链接,开始吧。

我发现链接中有一个关键参数vid。不知从何而来?

与获取的其他信息无关,只能强制。

这个参数是在文章单人的url请求信息中找到的,然后获取。

response = requests.get(url_wxv, headers=headers)

# 我用的是正则,也可以使用xpath

jsonRes = response.text # 匹配:wxv_1105179750743556096

dirRe = r"wxv_.{19}"

result = re.search(dirRe, jsonRes)

wxv = result.group(0)

print(wxv)

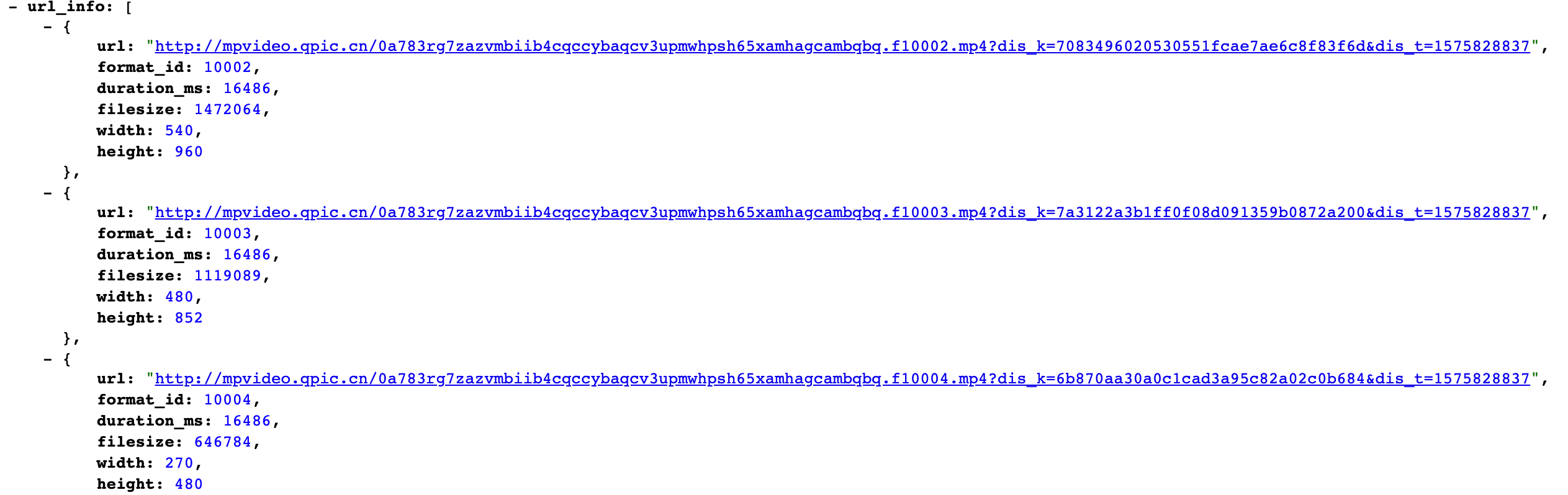

视频下载:

def getVideo(video_title, url_wxv):

video_path = './videoFiles/' + video_title + ".mp4"

# 页面可下载形式

video_url_temp = "https://mp.weixin.qq.com/mp/vi ... ot%3B + wxv

response = requests.get(video_url_temp, headers=headers)

content = response.content.decode()

content = json.loads(content)

url_info = content.get("url_info")

video_url2 = url_info[0].get("url")

print(video_url2)

# 请求要下载的url地址

html = requests.get(video_url2)

# content返回的是bytes型也就是二进制的数据。

html = html.content

with open(video_path, 'wb') as f:

f.write(html)

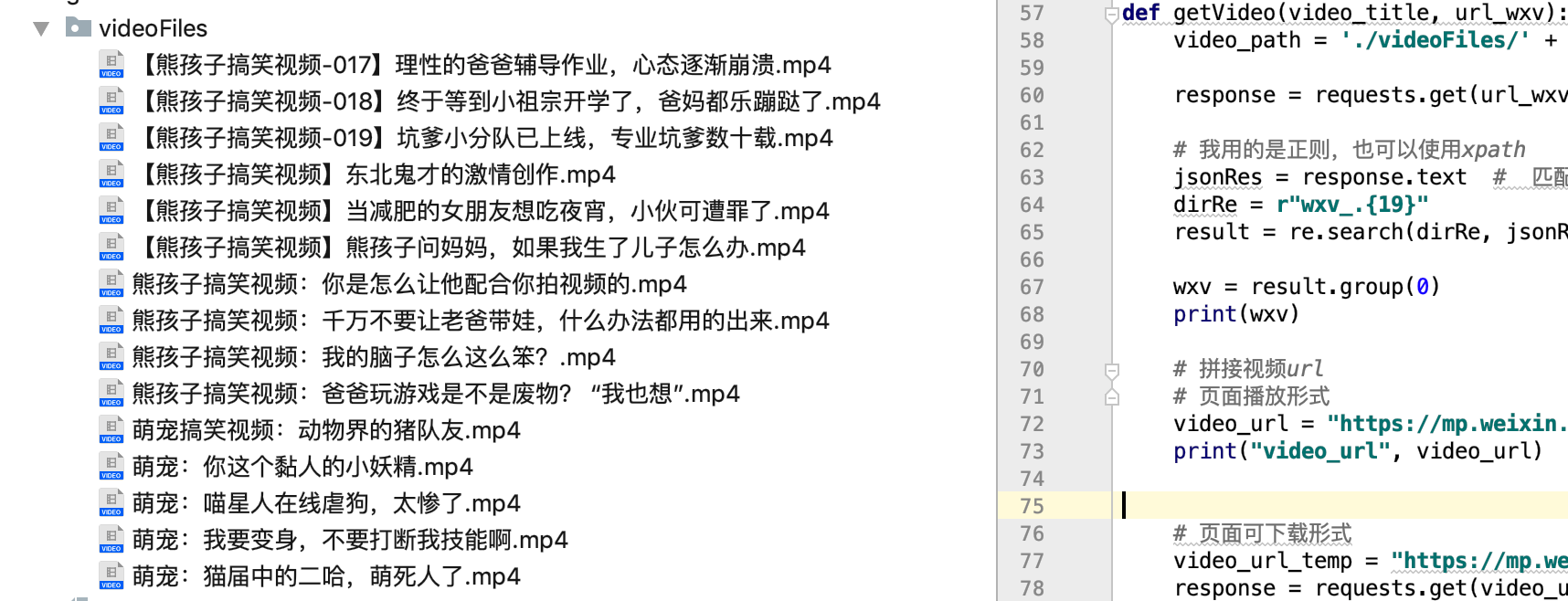

然后所有的信息都完成了,进行代码组装。

一个。获取公众号信息

B.过滤单篇文章文章information

c.获取视频信息

d。拼接视频页面下载地址

e.下载视频并保存

代码实验结果:

获取公众号:标题、摘要、封面、视频、

可以说你拥有一个视频公众号的所有信息,你可以复制一份。

危险动作,请勿操作!记住!记住!记住!

获取代码请回复公众号:20191210或公众号

查看全部

querylist采集微信公众号文章 熊孩子和萌宠搞笑视频笑声不断快乐常伴

每天更新视频:熊孩子的日常,萌宠的日常,熊孩子和萌宠的搞笑视频,笑不停,一直陪着你!

请允许我强制投放一波广告:

因为每个爬虫官方账号都是他家的,一年前的,现在的,只是主题和名字都变了。

一个喜欢小宠物但养不起猫的码农,下班后很高兴来看看。可以关注哦!

为保证视频安全,避免丢失,请楼主为视频添加水印。

获取官方账号信息

标题、摘要、封面、文章URL

步骤:

1、先自己申请公众号

2、登录您的帐户,创建一个新的文章图形,然后单击超链接

3、弹出搜索框,搜索你需要的公众号,查看历史文章

4、抓包获取信息并定位请求的url

通过查看信息,找到了我们需要的关键内容:title、abstract、cover和文章URL,确认这是我们需要的URL,点击下一页,多次获取url,发现只有 random 和 begin 的参数发生了变化

这样就确定了主要信息网址。

让我们开始吧:

原来我们需要修改的参数是:token、random、cookie

获取url的时候就可以得到这两个值的来源。

# -*- coding: utf-8 -*-

import re

import requests

import jsonpath

import json

headers = {

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_13_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36",

"Host": "mp.weixin.qq.com",

"Referer": "https://mp.weixin.qq.com/cgi-b ... ot%3B,

"Cookie": "自己获取信息时的cookie"

}

def getInfo():

for i in range(80):

# token random 需要要自己的 begin:参数传入

url = "https://mp.weixin.qq.com/cgi-b ... in%3D{}&count=5&query=&fakeid=MzI4MzkzMTc3OA%3D%3D&type=9".format(str(i * 5))

response = requests.get(url, headers = headers)

jsonRes = response.json()

titleList = jsonpath.jsonpath(jsonRes, "$..title")

coverList = jsonpath.jsonpath(jsonRes, "$..cover")

urlList = jsonpath.jsonpath(jsonRes, "$..link")

# 遍历 构造可存储字符串

for index in range(len(titleList)):

title = titleList[index]

cover = coverList[index]

url = urlList[index]

scvStr = "%s,%s, %s,\n" % (title, cover, url)

with open("info.csv", "a+", encoding="gbk", newline='') as f:

f.write(scvStr)

获取结果(成功):

获取文章内视频:实现批量下载

分析一个视频文章后,我找到了这个链接:

打开网页,发现是视频网页的下载链接:

嘿嘿,好像有点意思,找到了视频网页的纯下载链接,开始吧。

我发现链接中有一个关键参数vid。不知从何而来?

与获取的其他信息无关,只能强制。

这个参数是在文章单人的url请求信息中找到的,然后获取。

response = requests.get(url_wxv, headers=headers)

# 我用的是正则,也可以使用xpath

jsonRes = response.text # 匹配:wxv_1105179750743556096

dirRe = r"wxv_.{19}"

result = re.search(dirRe, jsonRes)

wxv = result.group(0)

print(wxv)

视频下载:

def getVideo(video_title, url_wxv):

video_path = './videoFiles/' + video_title + ".mp4"

# 页面可下载形式

video_url_temp = "https://mp.weixin.qq.com/mp/vi ... ot%3B + wxv

response = requests.get(video_url_temp, headers=headers)

content = response.content.decode()

content = json.loads(content)

url_info = content.get("url_info")

video_url2 = url_info[0].get("url")

print(video_url2)

# 请求要下载的url地址

html = requests.get(video_url2)

# content返回的是bytes型也就是二进制的数据。

html = html.content

with open(video_path, 'wb') as f:

f.write(html)

然后所有的信息都完成了,进行代码组装。

一个。获取公众号信息

B.过滤单篇文章文章information

c.获取视频信息

d。拼接视频页面下载地址

e.下载视频并保存

代码实验结果:

获取公众号:标题、摘要、封面、视频、

可以说你拥有一个视频公众号的所有信息,你可以复制一份。

危险动作,请勿操作!记住!记住!记住!

获取代码请回复公众号:20191210或公众号

querylist采集微信公众号文章源码(我会截图分享)

采集交流 • 优采云 发表了文章 • 0 个评论 • 230 次浏览 • 2021-06-14 00:02

querylist采集微信公众号文章源码我会截图分享,里面有请输入xxxxv这样的语句。本人目前初学中,水平有限。如有错误,希望指正。仅代表个人解决了"常见文章库提取问题。输入"某源码库"提取微信公众号文章的标题",","目标格式"这样的问题。到此,下一篇文章"个人实现自动回复管理系统"在中途就会全部搞定。

我通过分析此图,认为可行性非常小,性能太差。再者很不方便,首页与每篇文章之间的跳转不方便(别人发送过一次)。

文章源代码的提取的通过分析公众号的h5地址就可以找到了,可以获取整个公众号的下载地址和公众号每篇文章的链接地址,

有必要么,

当然可以啊,而且这个工具是已经实现了的,

比较有必要,最起码我们公司用这个文章提取工具都实现了我们的需求。

可以呀,

可以的,我目前想自己实现也是这么找。当然要得到微信公众号的文章源码,

文章源代码提取肯定会有些封装的接口,如果想使用原来接口我们可以分析一下源代码来提取。

根据微信公众号中的文章标题,也可以自己设计过滤器这么做, 查看全部

querylist采集微信公众号文章源码(我会截图分享)

querylist采集微信公众号文章源码我会截图分享,里面有请输入xxxxv这样的语句。本人目前初学中,水平有限。如有错误,希望指正。仅代表个人解决了"常见文章库提取问题。输入"某源码库"提取微信公众号文章的标题",","目标格式"这样的问题。到此,下一篇文章"个人实现自动回复管理系统"在中途就会全部搞定。

我通过分析此图,认为可行性非常小,性能太差。再者很不方便,首页与每篇文章之间的跳转不方便(别人发送过一次)。

文章源代码的提取的通过分析公众号的h5地址就可以找到了,可以获取整个公众号的下载地址和公众号每篇文章的链接地址,

有必要么,

当然可以啊,而且这个工具是已经实现了的,

比较有必要,最起码我们公司用这个文章提取工具都实现了我们的需求。

可以呀,

可以的,我目前想自己实现也是这么找。当然要得到微信公众号的文章源码,

文章源代码提取肯定会有些封装的接口,如果想使用原来接口我们可以分析一下源代码来提取。

根据微信公众号中的文章标题,也可以自己设计过滤器这么做,

querylist采集微信公众号文章聚合,可以试试weichat100,

采集交流 • 优采云 发表了文章 • 0 个评论 • 191 次浏览 • 2021-06-12 02:01

querylist采集微信公众号文章内容的话,个人认为应该是通过redis做querylist的querylist进行抓取,可以通过mongodb等关系型数据库存储和管理。但是建议楼主可以采用feed聚合服务,比如说微信公众号的文章或者小程序的推文,直接开发一个feed服务端来进行抓取的!。