php抓取网页动态数据

php抓取网页动态数据(视觉上的“动态效果”没有直接关系怎么做?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-11-09 14:00

这里所说的动态网页与网页上的各种动画、滚动字幕等视觉“动态效果”没有直接关系。动态网页也可以是纯文本内容或收录各种动画的内容。这些只是无论网页是否有动态效果,通过动态网站技术生成的网页都称为动态网页。

从网站查看者的角度来看,动态和静态网页都可以显示基本的文字和图片信息,但是从网站的开发、管理、维护的角度来看,差别很大。

早期的动态网页主要使用通用网关接口(CGI)技术。您可以使用不同的程序来编写合适的 CGI 程序,例如 Visual Basic、Delphi 或 C/C++。CGI技术虽然已经成熟,功能强大,但由于编程困难、效率低、修改复杂,有逐渐被新技术取代的趋势。

对应静态网页,可以与后端数据库交互,传输数据。也就是说,网页URL的后缀不是.htm、.html、.shtml、.xml等静态网页常见的动态网页创建格式,而是.aspx、.asp、.jsp、. php,.perl,。cgi等形式都是后缀,还有一个标志性的符号——“?” 在动态网页 URL 中。

特征

简要概括如下:

(1)动态网页一般基于数据库技术,可以大大减少网站维护的工作量;

(2)网站采用动态网页技术可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)动态网页实际上并不是独立存在于服务器上的网页文件,服务器只有在用户请求时才返回完整的网页;

(4)动态网页中的“?”对搜索引擎检索有一定的问题,搜索引擎一般不可能访问到网站的数据库中的所有网页,或者出于技术考虑,搜索蜘蛛可以不抓取网址中“?”后的内容,因此使用动态网页的网站在进行搜索引擎推广时需要做一定的技术处理以满足搜索引擎的要求。

客户端脚本

客户端脚本更改特定网页上的界面和行为,或响应鼠标或键盘操作,或在指定时间响应事件。在这种情况下,动态行为发生时就会发生。客户端生成的内容在用户的本地计算机系统中。

这些网页所使用的呈现技术称为富界面页面。客户端脚本语言,例如 JavaScript (Java Script) 或 ActionScript (ActionScript),使用动态 HTML (DHTML) 和 Flash 技术,通常用于组织媒体类型(声音、动画、修改后的文本等)的演示。 )。该脚本还允许使用远程脚本技术,DHTML 页面从服务器请求其他信息,使用隐藏框架、XMLHttpRequest 或 Web(网络)服务。

服务器端脚本

在 Web 服务器上运行的程序(服务器端脚本)用于更改不同网页上的网页内容,或调整顺序或重新加载网页。服务器响应以确定这种情况、发布的超文本标记语言形式的数据、URL 中的参数、使用的浏览器类型、时间流逝或数据库或服务器的状态。

这些网页通常是 ASP、ColdFusion、Perl、PHP、WebDNA 或其他服务器端语言。这些服务器端语言经常使用通用网关接口(CGI)来生成动态网页。JSP(Java Server Pages)有两个明显的例外,其中 CGI 的概念将在其 API(编程接口)中重用,但实际上所有 web(网络)请求都被分派到共享虚拟机。当动态网页几乎没有或没有预期更改时,它们通常会被缓存,并且页面预计会收到大量网络流量,这会导致服务器加载时间变慢。 查看全部

php抓取网页动态数据(视觉上的“动态效果”没有直接关系怎么做?(一))

这里所说的动态网页与网页上的各种动画、滚动字幕等视觉“动态效果”没有直接关系。动态网页也可以是纯文本内容或收录各种动画的内容。这些只是无论网页是否有动态效果,通过动态网站技术生成的网页都称为动态网页。

从网站查看者的角度来看,动态和静态网页都可以显示基本的文字和图片信息,但是从网站的开发、管理、维护的角度来看,差别很大。

早期的动态网页主要使用通用网关接口(CGI)技术。您可以使用不同的程序来编写合适的 CGI 程序,例如 Visual Basic、Delphi 或 C/C++。CGI技术虽然已经成熟,功能强大,但由于编程困难、效率低、修改复杂,有逐渐被新技术取代的趋势。

对应静态网页,可以与后端数据库交互,传输数据。也就是说,网页URL的后缀不是.htm、.html、.shtml、.xml等静态网页常见的动态网页创建格式,而是.aspx、.asp、.jsp、. php,.perl,。cgi等形式都是后缀,还有一个标志性的符号——“?” 在动态网页 URL 中。

特征

简要概括如下:

(1)动态网页一般基于数据库技术,可以大大减少网站维护的工作量;

(2)网站采用动态网页技术可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)动态网页实际上并不是独立存在于服务器上的网页文件,服务器只有在用户请求时才返回完整的网页;

(4)动态网页中的“?”对搜索引擎检索有一定的问题,搜索引擎一般不可能访问到网站的数据库中的所有网页,或者出于技术考虑,搜索蜘蛛可以不抓取网址中“?”后的内容,因此使用动态网页的网站在进行搜索引擎推广时需要做一定的技术处理以满足搜索引擎的要求。

客户端脚本

客户端脚本更改特定网页上的界面和行为,或响应鼠标或键盘操作,或在指定时间响应事件。在这种情况下,动态行为发生时就会发生。客户端生成的内容在用户的本地计算机系统中。

这些网页所使用的呈现技术称为富界面页面。客户端脚本语言,例如 JavaScript (Java Script) 或 ActionScript (ActionScript),使用动态 HTML (DHTML) 和 Flash 技术,通常用于组织媒体类型(声音、动画、修改后的文本等)的演示。 )。该脚本还允许使用远程脚本技术,DHTML 页面从服务器请求其他信息,使用隐藏框架、XMLHttpRequest 或 Web(网络)服务。

服务器端脚本

在 Web 服务器上运行的程序(服务器端脚本)用于更改不同网页上的网页内容,或调整顺序或重新加载网页。服务器响应以确定这种情况、发布的超文本标记语言形式的数据、URL 中的参数、使用的浏览器类型、时间流逝或数据库或服务器的状态。

这些网页通常是 ASP、ColdFusion、Perl、PHP、WebDNA 或其他服务器端语言。这些服务器端语言经常使用通用网关接口(CGI)来生成动态网页。JSP(Java Server Pages)有两个明显的例外,其中 CGI 的概念将在其 API(编程接口)中重用,但实际上所有 web(网络)请求都被分派到共享虚拟机。当动态网页几乎没有或没有预期更改时,它们通常会被缓存,并且页面预计会收到大量网络流量,这会导致服务器加载时间变慢。

php抓取网页动态数据(php静态网站建设纯粹HTML格式的网页通常被称为)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-11-09 13:07

在网站的设计中,纯HTML格式的网页通常被称为“静态网页”,早期的网站一般都是由静态网页制作的。以下是学习编辑器为大家整理的PHP静态网站构建,希望大家喜欢!

php 静态 网站 构造

1.静态网站

在网站的设计中,纯HTML格式的网页通常被称为“静态网页”,早期的网站一般都是由静态网页制作的。

静态网站的特点简单总结如下:

(1)静态网站每个网页都有固定的网址,网页网址后缀为.htm、.html、.shtml等常见形式,不收录“?”;

(2)网站一旦内容发布在网站服务器上,无论用户是否访问,每个静态网页的内容都存储在网站服务器上,即比如说,静态网站是实际存放在服务器上的文件,每个网页都是一个独立的文件;

(3)static网站的内容比较稳定,容易被搜索引擎检索到;

(4)静态网站没有数据库支持,网站的制作和维护工作量很大,所以当网站信息量很大的时候,完全依赖静态网页制作方法难度较大;

(5)Static 网站的交互%%交叉,在功能上有较大的局限性。

静态 网站 缺点

1.网站设计基于静态页面,网站更新必须由专业人员完成;

2.网站只有宣传功能,缺少互动功能,效果不是很好;

3.网站 人力资源长期维护难;

4.网站长期发展后劲不足;

静态网站的优点

1.安全、静态网站 理论上不存在攻击漏洞;

2. 无数据库访问或服务器对数据响应的负载降低,速度快;

3.优化引擎,易于搜索引擎收录,搜索引擎更喜欢收录静态页面;

4.降低服务器的承受能力,因为可以不解析就返回给客户端,从而减少服务器的工作量,也降低了数据库的成本。

php动态网站构建

2.动态网站

动态网站对应静态网站,即网页URL的后缀不是.htm、.html、.shtml、.xml等静态网站的常见形式,并且以.asp、.jsp、.php、.cgi等形式为后缀,动态网站 URL中有一个标志性的符号-“?”

这里所说的动态网站与网页上各种动画、滚动字幕等视觉“动态效果”没有直接关系。动态网站也可以是纯文本内容或者收录各种动画的内容,这些只是网页具体内容的体现,不管网页是否有动态效果,动态网站生成的网页@> 技术被称为动态网站。

从网站浏览者的角度来看,无论是动态的网站还是静态的网页都可以显示基本的文字图片信息,但是从网站的开发、管理、维护的角度来看,有很大的区别。

动态网站的特点:

(1)动态网站基于数据库技术,可以大大减少网站维护的工作量;

(2)使用动态网站技术网站可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)Dynamic网站其实并不是一个独立存在于服务器上的网页文件,服务器只有在用户请求时才返回一个完整的网页;

(4)dynamics网站中的“?”在搜索引擎检索上有一定的问题,搜索引擎一般无法访问网站的数据库中的所有网页,或者技术原因考虑到搜索蜘蛛不会抓取网址中“?”后的内容,因此在进行搜索引擎推广时使用动态网站网站需要一定的技术处理才能满足搜索引擎的要求。

动态网站优势

1.易于更新:网站 内容更新实现“傻瓜式”,普通员工即可完成。

2.完成后解决网站维护问题(长期发展)。

3.可扩展和可升级:网站的内容被记录在数据库中,以后网站会被修改和升级。这些内容可以导入不会丢失,功能也可以移动,避免完全重建站台,避免重复投资和浪费。

4.将企业网站的建设从单纯的静态页面制作扩展到企业对信息资源的组织管理。

如何优化PHP静态网站

1.静态动态页面

2.优化数据库

3.使用负载均衡

4.使用缓存

5.使用CDN加速

现在很多网站在构建过程中都需要静态处理。为什么要对 网站 进行静态处理?我们都知道纯静态网站就是所有的网页都是独立的一个html页面,我们访问的时候不用数据处理就可以直接读取。访问速度可想而知,也是对搜索引擎非常友好的一种方式。

网站中的纯静态网站是如何实现的?

纯静态制作技术是先对网站的页面进行汇总,分成几种样式,然后将这些页面制作成模板。生成的时候,必须先读取源文件,然后生成一个独立的以.html结尾的页面文件,所以纯静态网站需要更多的空间,但其实需要的空间并不多,尤其是中小型大型企业网站,技术上来说,大型网站实现全站纯静态化难度较大,生成时间过长。不过中小网站还是纯静态对比,优点很多。

动态 网站 是如何静态处理的?

页面静态化是指将动态页面变成html/htm静态页面。动态页面一般采用asp、php、jsp、.net等编程语言编写,非常易于管理。但是,在访问网页时,程序需要先对其进行处理,因此访问速度相对较慢。静态页面访问速度快,但不易管理。那么静态动态页面就可以将两种页面的优点结合起来。

静态处理给网站带来什么好处?

1.静态页面比动态页面更容易被搜索引擎搜索到收录。

2.访问静态页面不需要程序处理,可以提高运行速度。

3.减轻服务器的负担。

4.HTML 页面不会受到 Asp 相关漏洞的影响。

静态处理后的网站比没有静态处理的网站相对安全,因为静态网站不会成为黑客的首选,因为黑客不知道在你的后台系统的情况下,黑客很难从前台的静态页面进行攻击。同时具有一定的稳定性。比如网站的数据库或程序有问题,不会干扰静态处理的页面,也不会因为程序或数据的影响而无法打开页面. 查看全部

php抓取网页动态数据(php静态网站建设纯粹HTML格式的网页通常被称为)

在网站的设计中,纯HTML格式的网页通常被称为“静态网页”,早期的网站一般都是由静态网页制作的。以下是学习编辑器为大家整理的PHP静态网站构建,希望大家喜欢!

php 静态 网站 构造

1.静态网站

在网站的设计中,纯HTML格式的网页通常被称为“静态网页”,早期的网站一般都是由静态网页制作的。

静态网站的特点简单总结如下:

(1)静态网站每个网页都有固定的网址,网页网址后缀为.htm、.html、.shtml等常见形式,不收录“?”;

(2)网站一旦内容发布在网站服务器上,无论用户是否访问,每个静态网页的内容都存储在网站服务器上,即比如说,静态网站是实际存放在服务器上的文件,每个网页都是一个独立的文件;

(3)static网站的内容比较稳定,容易被搜索引擎检索到;

(4)静态网站没有数据库支持,网站的制作和维护工作量很大,所以当网站信息量很大的时候,完全依赖静态网页制作方法难度较大;

(5)Static 网站的交互%%交叉,在功能上有较大的局限性。

静态 网站 缺点

1.网站设计基于静态页面,网站更新必须由专业人员完成;

2.网站只有宣传功能,缺少互动功能,效果不是很好;

3.网站 人力资源长期维护难;

4.网站长期发展后劲不足;

静态网站的优点

1.安全、静态网站 理论上不存在攻击漏洞;

2. 无数据库访问或服务器对数据响应的负载降低,速度快;

3.优化引擎,易于搜索引擎收录,搜索引擎更喜欢收录静态页面;

4.降低服务器的承受能力,因为可以不解析就返回给客户端,从而减少服务器的工作量,也降低了数据库的成本。

php动态网站构建

2.动态网站

动态网站对应静态网站,即网页URL的后缀不是.htm、.html、.shtml、.xml等静态网站的常见形式,并且以.asp、.jsp、.php、.cgi等形式为后缀,动态网站 URL中有一个标志性的符号-“?”

这里所说的动态网站与网页上各种动画、滚动字幕等视觉“动态效果”没有直接关系。动态网站也可以是纯文本内容或者收录各种动画的内容,这些只是网页具体内容的体现,不管网页是否有动态效果,动态网站生成的网页@> 技术被称为动态网站。

从网站浏览者的角度来看,无论是动态的网站还是静态的网页都可以显示基本的文字图片信息,但是从网站的开发、管理、维护的角度来看,有很大的区别。

动态网站的特点:

(1)动态网站基于数据库技术,可以大大减少网站维护的工作量;

(2)使用动态网站技术网站可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

(3)Dynamic网站其实并不是一个独立存在于服务器上的网页文件,服务器只有在用户请求时才返回一个完整的网页;

(4)dynamics网站中的“?”在搜索引擎检索上有一定的问题,搜索引擎一般无法访问网站的数据库中的所有网页,或者技术原因考虑到搜索蜘蛛不会抓取网址中“?”后的内容,因此在进行搜索引擎推广时使用动态网站网站需要一定的技术处理才能满足搜索引擎的要求。

动态网站优势

1.易于更新:网站 内容更新实现“傻瓜式”,普通员工即可完成。

2.完成后解决网站维护问题(长期发展)。

3.可扩展和可升级:网站的内容被记录在数据库中,以后网站会被修改和升级。这些内容可以导入不会丢失,功能也可以移动,避免完全重建站台,避免重复投资和浪费。

4.将企业网站的建设从单纯的静态页面制作扩展到企业对信息资源的组织管理。

如何优化PHP静态网站

1.静态动态页面

2.优化数据库

3.使用负载均衡

4.使用缓存

5.使用CDN加速

现在很多网站在构建过程中都需要静态处理。为什么要对 网站 进行静态处理?我们都知道纯静态网站就是所有的网页都是独立的一个html页面,我们访问的时候不用数据处理就可以直接读取。访问速度可想而知,也是对搜索引擎非常友好的一种方式。

网站中的纯静态网站是如何实现的?

纯静态制作技术是先对网站的页面进行汇总,分成几种样式,然后将这些页面制作成模板。生成的时候,必须先读取源文件,然后生成一个独立的以.html结尾的页面文件,所以纯静态网站需要更多的空间,但其实需要的空间并不多,尤其是中小型大型企业网站,技术上来说,大型网站实现全站纯静态化难度较大,生成时间过长。不过中小网站还是纯静态对比,优点很多。

动态 网站 是如何静态处理的?

页面静态化是指将动态页面变成html/htm静态页面。动态页面一般采用asp、php、jsp、.net等编程语言编写,非常易于管理。但是,在访问网页时,程序需要先对其进行处理,因此访问速度相对较慢。静态页面访问速度快,但不易管理。那么静态动态页面就可以将两种页面的优点结合起来。

静态处理给网站带来什么好处?

1.静态页面比动态页面更容易被搜索引擎搜索到收录。

2.访问静态页面不需要程序处理,可以提高运行速度。

3.减轻服务器的负担。

4.HTML 页面不会受到 Asp 相关漏洞的影响。

静态处理后的网站比没有静态处理的网站相对安全,因为静态网站不会成为黑客的首选,因为黑客不知道在你的后台系统的情况下,黑客很难从前台的静态页面进行攻击。同时具有一定的稳定性。比如网站的数据库或程序有问题,不会干扰静态处理的页面,也不会因为程序或数据的影响而无法打开页面.

php抓取网页动态数据(做网站seo优化必须了解的一个专业术语URL是什么呢)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-11-07 12:06

网站seo 优化必须了解专业术语 URL。那么网址是什么呢?通俗地说,URL就是网站中涉及的各种链接,通常可以细分为静态链接、动态链接和伪静态链接。那么什么是静态、动态和伪静态链接呢?他们之间是什么关系?

在互联网开始的时代,几乎都是静态链接。后来网站asp、jsp、php等后台语言不断完善,开始出现动态链接,但是问题来了。动态链接的早期情况如何?搜索引擎很麻烦,很费时间,处理起来也很复杂,所以被抓到收录的几率比较低,所以就有了伪静态的东西。伪静态链接本质上是动态链接,但是通过相应的算法规则将动态链接伪装成静态链接。那么我们来看看这三个是什么。

一、静态链接

一种。静态页面的 URL 链接使用 .html、htm、.shtml 和 .xml 作为链接后缀。

湾 静态页面是存在于服务器上的一个文件,每个页面都是一个独立的文件;

C。客户端加载静态页面时,并不操作数据库,而是直接提取一个文件。

d. 没有数据库;

静态链接一般是这样的:“/1-1.html”,但是你会发现很多伪静态也是这样的,那怎么区分呢?一般来说,不容易区分,你可以去服务器看看这个伪静态链接对应的页面是否是一个独立的文件。

优点:与其他两种页面相比,加载速度更快,无需从数据库中提取数据,对服务器没有压力。对于SEO优化,静态链接和静态页面对搜索引擎非常友好。

缺点:因为数据是用HTML存储的,文件很大。最严重的是,源代码必须一一修改。如果是一个很大的网站,数据量很大,会占用大量的服务器空间,每次添加内容都会生成一个新的HTML页面。维护成本很高。因此,此类静态页面在使用中一般很小网站。

二、动态链接

动态链接是智能分配链接的结果。它看起来像这样:“/?%xxxx”。问号后面是一堆参数。它的特点是什么?

一种。用ASP、PHP、JSP等多种编程语言制作;

湾 它不是一个独立存在于服务器上的网页文件,只有在用户请求时服务器才返回一个完整的网页;

C。内容存在于数据库中,根据用户发送的不同请求,提供个性化的网页内容;

d. 内容不存在于页面上,而是存在于数据库中,大大减少了网站维护的工作量。

优点:节省空间。数以万计的数据通常只有几兆字节的大小。直接从数据库更改可以自动更新到所有动态页面。如今,搜索引擎对动态链接的索引几乎和静态链接一样困难。但是按照搜索引擎友好的原则,处理好链接会让搜索引擎更省心。

缺点:用户访问速度慢。服务器上有一个解析引擎,主要是将动态页面翻译成静态页面,也就是你在一个页面上查看源代码的那部分代码,这部分代码是经过翻译处理的。和静态页面相比,多了一个处理步骤,慢了也是正常的。并且由于动态页面的数据是调用数据库的显示结果,大量访问者很容易造成访问缓慢甚至崩溃。

三、伪静态链接

优点:优点是让搜索引擎把自己的网页当成静态页面。搜索引擎友好 upupup!它是一种结合了静态和动态链接优点的产品。也是目前大多数SEOer推荐的连接形式。 查看全部

php抓取网页动态数据(做网站seo优化必须了解的一个专业术语URL是什么呢)

网站seo 优化必须了解专业术语 URL。那么网址是什么呢?通俗地说,URL就是网站中涉及的各种链接,通常可以细分为静态链接、动态链接和伪静态链接。那么什么是静态、动态和伪静态链接呢?他们之间是什么关系?

在互联网开始的时代,几乎都是静态链接。后来网站asp、jsp、php等后台语言不断完善,开始出现动态链接,但是问题来了。动态链接的早期情况如何?搜索引擎很麻烦,很费时间,处理起来也很复杂,所以被抓到收录的几率比较低,所以就有了伪静态的东西。伪静态链接本质上是动态链接,但是通过相应的算法规则将动态链接伪装成静态链接。那么我们来看看这三个是什么。

一、静态链接

一种。静态页面的 URL 链接使用 .html、htm、.shtml 和 .xml 作为链接后缀。

湾 静态页面是存在于服务器上的一个文件,每个页面都是一个独立的文件;

C。客户端加载静态页面时,并不操作数据库,而是直接提取一个文件。

d. 没有数据库;

静态链接一般是这样的:“/1-1.html”,但是你会发现很多伪静态也是这样的,那怎么区分呢?一般来说,不容易区分,你可以去服务器看看这个伪静态链接对应的页面是否是一个独立的文件。

优点:与其他两种页面相比,加载速度更快,无需从数据库中提取数据,对服务器没有压力。对于SEO优化,静态链接和静态页面对搜索引擎非常友好。

缺点:因为数据是用HTML存储的,文件很大。最严重的是,源代码必须一一修改。如果是一个很大的网站,数据量很大,会占用大量的服务器空间,每次添加内容都会生成一个新的HTML页面。维护成本很高。因此,此类静态页面在使用中一般很小网站。

二、动态链接

动态链接是智能分配链接的结果。它看起来像这样:“/?%xxxx”。问号后面是一堆参数。它的特点是什么?

一种。用ASP、PHP、JSP等多种编程语言制作;

湾 它不是一个独立存在于服务器上的网页文件,只有在用户请求时服务器才返回一个完整的网页;

C。内容存在于数据库中,根据用户发送的不同请求,提供个性化的网页内容;

d. 内容不存在于页面上,而是存在于数据库中,大大减少了网站维护的工作量。

优点:节省空间。数以万计的数据通常只有几兆字节的大小。直接从数据库更改可以自动更新到所有动态页面。如今,搜索引擎对动态链接的索引几乎和静态链接一样困难。但是按照搜索引擎友好的原则,处理好链接会让搜索引擎更省心。

缺点:用户访问速度慢。服务器上有一个解析引擎,主要是将动态页面翻译成静态页面,也就是你在一个页面上查看源代码的那部分代码,这部分代码是经过翻译处理的。和静态页面相比,多了一个处理步骤,慢了也是正常的。并且由于动态页面的数据是调用数据库的显示结果,大量访问者很容易造成访问缓慢甚至崩溃。

三、伪静态链接

优点:优点是让搜索引擎把自己的网页当成静态页面。搜索引擎友好 upupup!它是一种结合了静态和动态链接优点的产品。也是目前大多数SEOer推荐的连接形式。

php抓取网页动态数据(PHP抓取网页代码,图片路径问题(一)_)

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2021-11-06 10:04

PHP抓取网页代码,图片路径问题

我现在首先使用php代码来抓取连接URL的代码。,

ob_start();

$ch = curl_init();

curl_setopt( $ch, CURLOPT_URL, $url );

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_HEADER, 0);

$retrievedhtml=curl_exec( $ch );

ob_end_clean();

curl_close( $ch );

现在我们遇到一种情况,比如网页的网址是

那么网页中图片的链接地址就是

这时候按理说图片的完整网址应该是

但是我转换之后,发现图片无法显示。后来我发现图片的路径其实是

你如何解释这一点,你应该如何判断这样的路径?

- - - 解决方案 - - - - - - - - - -

按常理,不是/bq/cq/a.jpg

好好看看这条路:

/到根

图片路径是

你多测几张图立马明白,/前面没有点,跳到根,如果有点,不要混淆当前路径。

- - - 解决方案 - - - - - - - - - -

形状像

相对于域名

形状像

或者

相对于 url

网站 不是自己写的吗?

就抓人?

内容推荐:免费高清PNG素材下载 查看全部

php抓取网页动态数据(PHP抓取网页代码,图片路径问题(一)_)

PHP抓取网页代码,图片路径问题

我现在首先使用php代码来抓取连接URL的代码。,

ob_start();

$ch = curl_init();

curl_setopt( $ch, CURLOPT_URL, $url );

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_HEADER, 0);

$retrievedhtml=curl_exec( $ch );

ob_end_clean();

curl_close( $ch );

现在我们遇到一种情况,比如网页的网址是

那么网页中图片的链接地址就是

这时候按理说图片的完整网址应该是

但是我转换之后,发现图片无法显示。后来我发现图片的路径其实是

你如何解释这一点,你应该如何判断这样的路径?

- - - 解决方案 - - - - - - - - - -

按常理,不是/bq/cq/a.jpg

好好看看这条路:

/到根

图片路径是

你多测几张图立马明白,/前面没有点,跳到根,如果有点,不要混淆当前路径。

- - - 解决方案 - - - - - - - - - -

形状像

相对于域名

形状像

或者

相对于 url

网站 不是自己写的吗?

就抓人?

内容推荐:免费高清PNG素材下载

php抓取网页动态数据(一下如何编写一个简单的PHP数据采集程序(PHP爬虫))

网站优化 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-11-01 12:10

前言

我们在写Web程序的时候,总会想到让我们的网站更加美观,功能更加强大。有时候写一些小工具或者添加小插件会让我们的网站更加完整。比如万年历功能,比如我们现在要讲的天气预报功能。

当然,我们无法使用专业卫星来接收数据,所以我们的天气数据来自现有的天气预报网站。利用天气预报网站提供的数据服务,我们可以写一个PHP爬虫,然后动态采集我们需要的数据,当目标站点更新数据时,我们的程序也可以同步更新,自动获取数据。

下面介绍如何编写一个简单的PHP数据程序(PHP爬虫)。

原则

给定一个网页的URL,使用PHP下载网页并获取网页内容,然后通过正则表达式提取我们感兴趣的数据,然后输出。

具体在这个例子中,我们要抓取的网页是我们对页面上未来7天的天气感兴趣。

实现0.获取天气预报网页的URL:

$url = "http://www.weather.com.cn/weat ... 3B%3B

$page_content = file_get_contents($url);

这里,file_get_contents() 函数会下载$url 指向的网页,并以字符串形式返回网页内容。因此,$page_content 变量收录了我们要抓取的网页的所有 HTML 代码。接下来,我们需要从中提取我们需要的数据。

1.使用正则表达式匹配符合条件的字符串

先输出$page_content的值,然后查看网页源码。观察到我们需要的字符串可以在

......

在这两行的注释中找到。

使用正则表达式获取和之间的所有内容:

eregi("(.*)",$page_content,$res);

2.完成页面上图片的路径

由于远程网页中的图片路径都是像/m2/i/icon_weather/29x20/d01.gif这样的相对路径,所以我们需要把这些路径补全,并在它们之前添加。

<p>$forecast = str_replace(" 查看全部

php抓取网页动态数据(一下如何编写一个简单的PHP数据采集程序(PHP爬虫))

前言

我们在写Web程序的时候,总会想到让我们的网站更加美观,功能更加强大。有时候写一些小工具或者添加小插件会让我们的网站更加完整。比如万年历功能,比如我们现在要讲的天气预报功能。

当然,我们无法使用专业卫星来接收数据,所以我们的天气数据来自现有的天气预报网站。利用天气预报网站提供的数据服务,我们可以写一个PHP爬虫,然后动态采集我们需要的数据,当目标站点更新数据时,我们的程序也可以同步更新,自动获取数据。

下面介绍如何编写一个简单的PHP数据程序(PHP爬虫)。

原则

给定一个网页的URL,使用PHP下载网页并获取网页内容,然后通过正则表达式提取我们感兴趣的数据,然后输出。

具体在这个例子中,我们要抓取的网页是我们对页面上未来7天的天气感兴趣。

实现0.获取天气预报网页的URL:

$url = "http://www.weather.com.cn/weat ... 3B%3B

$page_content = file_get_contents($url);

这里,file_get_contents() 函数会下载$url 指向的网页,并以字符串形式返回网页内容。因此,$page_content 变量收录了我们要抓取的网页的所有 HTML 代码。接下来,我们需要从中提取我们需要的数据。

1.使用正则表达式匹配符合条件的字符串

先输出$page_content的值,然后查看网页源码。观察到我们需要的字符串可以在

......

在这两行的注释中找到。

使用正则表达式获取和之间的所有内容:

eregi("(.*)",$page_content,$res);

2.完成页面上图片的路径

由于远程网页中的图片路径都是像/m2/i/icon_weather/29x20/d01.gif这样的相对路径,所以我们需要把这些路径补全,并在它们之前添加。

<p>$forecast = str_replace("

php抓取网页动态数据(我的脚本无法返回除之外的任何内容[01])

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-10-27 10:11

我正在尝试获取 .htm 链接,但我的脚本无法返回除“[]”之外的任何内容。

链接=

import requests

from bs4 import BeautifulSoup as bs

link = 'https://www.forwardhealth.wi.gov/WIPortal/StaticContent/Member/caseloads/481-caseload.htm'

headers = {'User-Agent':'Mozilla/5.0'}

r = requests.get(link, headers=headers)

soup = bs(r.text, 'lxml') #I've tried other html parsers in here as well as r.content

我认为问题在于我试图与页面交互(可能是错误的编码?)。上面的格式是我过去所有的网络爬虫都是这样设置的,没有遇到什么我解决不了的问题。最突出的是当我调用 r.content 或 r.text 并收到一个看起来很奇怪的响应时:

'\r\n\r\n\r\n'

这让我觉得我的脚本写错了,无法处理上述任何一项。我以前从未见过“Microsoft FrontPage 5.0”,我不知道这是不是我的代码崩溃的原因。我试图通过在此处更改 r.encoding = #encoding 来强制编码。任何指导都会有所帮助。 查看全部

php抓取网页动态数据(我的脚本无法返回除之外的任何内容[01])

我正在尝试获取 .htm 链接,但我的脚本无法返回除“[]”之外的任何内容。

链接=

import requests

from bs4 import BeautifulSoup as bs

link = 'https://www.forwardhealth.wi.gov/WIPortal/StaticContent/Member/caseloads/481-caseload.htm'

headers = {'User-Agent':'Mozilla/5.0'}

r = requests.get(link, headers=headers)

soup = bs(r.text, 'lxml') #I've tried other html parsers in here as well as r.content

我认为问题在于我试图与页面交互(可能是错误的编码?)。上面的格式是我过去所有的网络爬虫都是这样设置的,没有遇到什么我解决不了的问题。最突出的是当我调用 r.content 或 r.text 并收到一个看起来很奇怪的响应时:

'\r\n\r\n\r\n'

这让我觉得我的脚本写错了,无法处理上述任何一项。我以前从未见过“Microsoft FrontPage 5.0”,我不知道这是不是我的代码崩溃的原因。我试图通过在此处更改 r.encoding = #encoding 来强制编码。任何指导都会有所帮助。

php抓取网页动态数据(娱乐小编是如何报道娱乐热点的?(一)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-10-23 12:10

八卦是人的本性。作为众多吃瓜群众中的一员,我当然不会放过娱乐圈的每一个热点。

接下来就抢企鹅娱乐版块

看看娱乐编辑如何报道娱乐热点。

具体目标如下:(红框标题)

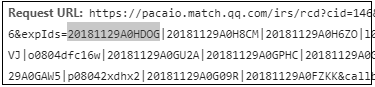

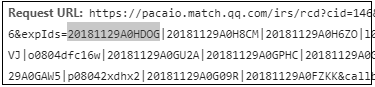

第一步是“观察与分析”,一直向下滚动,右键查看源码,右键查看,这些是基本操作,可以发现网站是ajax加载,还有返回的数据是Json,如下图:

然后就可以进行基本的爬取了,代码如下(文件名为news_of_ent_v1.py):

import requests

import json

import uagent #我自己编写的一个获取随机user-agent的脚本,可参考https://blog.csdn.net/eighttoe ... 96377

url = ('https://pacaio.match.qq.com/irs/rcd?cid=146&token=49cbb2154853ef1a74ff4e5372337'

'2ce&ext=ent&page=3&expIds=20181129V094JT|20181129A09LA4|20181129A09DI3|h08046y2'

'39w|20181129A0AEFT|20181129A09L7P|20181129A0A0A3|w0804cm6v49|20181129A07WGU|201'

'81129V07R1F|20181129A07YTG|i0804um2sgw|20181129A03RFA|20181129V08K9U|20181129A0'

'752A|r0804pauuow|20181129A03M8L|20181129V05VUW|20181129A07RY8|i0804rrvezl&callb'

'ack=__jp9')

def get_page(url):

headers = {'User-Agent': uagent.get_ua()}

response = requests.get(url = url, headers = headers)

index = response.text.index('{')

text = response.text[index:-1] #因为返回的字符串不符合Json格式,所有需要截取

return text

def parse(text):

dic = json.loads(text)

for i in dic['data']:

title = i['title']

print(title)

if __name__ == '__main__':

text = get_page(url)

parse(text)

第三步,可以开始考虑如何从多个页面抓取数据。一般来说,你可以观察多个 URL 之间的规则。

| 20181129A0GCCJ | 20181129A0CWFL | m0804l0n718 | 20181129A0DXZT | 20181128A041V1 | 20181129A0BAHH | l0804e3dmbo | 20181129A0F6R9 | 20181129A0EESO | 20181127A154YM | l0804qtam7g | 20181129A0ETEU | 20181129A0H1J0 | 20181129V0EZAD | i0804iftf8b | 20181129A0HEU1 | 20181129A0HEA6 & 回调 = __ jp11

| 20181129A0H8CM | 20181129A0H6ZO | l0804e3dmbo | 20181129A0H6JU | 20181129A0H1D0 | 20181129A0H0VJ | o0804dfc16w | 20181129A0GU2A | 20181129A0GPHC | 20181129A0GJF9 | w08042hmn7v | 20181129A0GEM6 | 20181129A0GCE0 | 20181129A0GAW5 | p08042xdhx2 | 20181129A0G09R | 20181129A0FZKK & 回调 = __ jp12

| 20181129A0FAHO | 20181129A0F9F9 | u080493vmrd | 20181129A0F8SG | 20181129A0F8KW | 20181129A0DQ1O | g0804wb0r2h | 20181129A0DIMJ | 20181129A0DFVG | 20181129A044D0 | z080490ojod | 20181127V1HHOY | 20181129A0CZBG | 20181129A0B8NS | i0804ilfina | 20181129A0D98X | 20181129A0AOPL | 20181129V05VUW & 回调 = __ jp13

改变的url参数是page、expIds和callback。

页面和回调很好理解,它是越来越多的数字。至于expIds,这么大的清单是什么?我从刚刚抓取的 Json 数据中找到了线索。id 字段构成下一页 url 的键。信息。

然后就可以开始编辑代码了,如下图(文件名为news_of_ent_v2.py):

import requests

import json

import uagent #我自己编写的一个获取随机user-agent的脚本,可参考https://blog.csdn.net/eighttoe ... 96377

def get_page(n, expIds): #page从1开始,callback = page + 6

base_url = 'https://pacaio.match.qq.com/irs/rcd'

payload = {

'cid': '146',

'token': '49cbb2154853ef1a74ff4e53723372ce',

'ext': 'ent',

'page': str(n),

'expIds': expIds,

'callback': '__jp' + str(n + 6)

}

headers = {'User-Agent': uagent.get_ua()}

response = requests.get(url = base_url, params = payload, headers = headers)

index = response.text.index('{')

text = response.text[index:-1] #因为返回的字符串不符合Json格式,所有需要截取

return text

def parse_title(text):

dic = json.loads(text)

for i in dic['data']:

title = i['title']

print(title)

def parse_id(text):

dic = json.loads(text)

expIds = ''

for i in dic['data']:

expIds += i['id']

expIds += '|'

return expIds[:-1]

if __name__ == '__main__':

expIds = ('20181129001615|20181129A0JFDT|20181128A0Z1JV|l0804gy5rsa|20181129A0K'

'LSB|20181129A0D0LP|20181129A02B6B|n0804d5mx3y|20181128A1K7IZ|20181129'

'A09LA4|20181129A060VB|s0804loccct|20181129A0KIZU|20181129A0AEFT|20181'

'129A0PGAG|w0804wyseww|20181129009640|20181129A0JLZQ|20181129A06G5R')

for n in range(1, 11):

text = get_page(n, expIds)

parse_title(text)

expIds = parse_id(text)

修改了get_page()函数,添加了构造url的逻辑,而不是直接把url当作参数传入,然后添加了一个解析expIds的函数。

第四步开始考虑保存数据,因为数据量不大,而且只有一个字段,直接保存为csv文件即可。

代码如下(文件名为news_of_ent_v3.py):

import requests

import json

import uagent #我自己编写的一个获取随机user-agent的脚本,可参考https://blog.csdn.net/eighttoe ... 96377

import csv

def get_page(n, expIds): #page从1开始,callback = page + 6

base_url = 'https://pacaio.match.qq.com/irs/rcd'

payload = {

'cid': '146',

'token': '49cbb2154853ef1a74ff4e53723372ce',

'ext': 'ent',

'page': str(n),

'expIds': expIds,

'callback': '__jp' + str(n + 6)

}

headers = {'User-Agent': uagent.get_ua()}

response = requests.get(url = base_url, params = payload, headers = headers)

index = response.text.index('{')

text = response.text[index:-1] #因为返回的字符串不符合Json格式,所有需要截取

return text

def parse_title(text):

dic = json.loads(text)

titles = [i['title'] for i in dic['data']]

return titles

def parse_id(text):

dic = json.loads(text)

expIds = ''

for i in dic['data']:

expIds += i['id']

expIds += '|'

return expIds[:-1]

def save(data):

#encoding用一个比较大的汉字字符集,防止出现不能识别的汉字

with open('titles.csv', 'a', newline = '', encoding = 'GB18030') as c:

writer = csv.writer(c)

for i in data:

writer.writerow([i])

if __name__ == '__main__':

#这里对第一个expIds进行硬编码

expIds = ('20181129001615|20181129A0JFDT|20181128A0Z1JV|l0804gy5rsa|20181129A0K'

'LSB|20181129A0D0LP|20181129A02B6B|n0804d5mx3y|20181128A1K7IZ|20181129'

'A09LA4|20181129A060VB|s0804loccct|20181129A0KIZU|20181129A0AEFT|20181'

'129A0PGAG|w0804wyseww|20181129009640|20181129A0JLZQ|20181129A06G5R')

for n in range(1, 11):

text = get_page(n, expIds)

data = parse_title(text)

save(data)

print('the', n, 'page ok')

expIds = parse_id(text)

将parse_title()函数改为返回一个列表推导式,并新增了一个save()函数。

####一开始,我打算抓取10000页的数据,但是大约20页之后,每页的标题数量从20个下降到4-5个。一开始以为是反爬虫策略。,于是我用浏览器加载了一下,发现是一样的。

然后当脚本抓取大约 2000 页时,没有返回标题。我觉得应该是企鹅直接删除旧的过期缓存。普通人不会阅读一个版本的新闻,并将其降到 2000 个。多页。. .

这里我挖了3235个标题,这里做一个简单的分析。

首先,我发现作为专业编辑,起标题的时候一定不能用句号,但是可以用问号吗?还有感叹号!

而且你不能用几个简单的词来开始标题。标题一般比较长,需要用逗号拼接。

至于标题,字数一般控制在20-32左右,只有极少数的字出现在10以下或35字以上。

既然标题一定要跟内容相关,相信只要有初中语文水平的同学都会知道这个道理。

虽然这几年头条党很多,但是头条里的主角一般都不是假的,所以你可以通过头条看看这两天(我是18年11月29日写的这个博客)谁是10个最流行艺人?

可见,基本与昨天(2018年11月28日)的娱乐新闻密不可分。除了赵丽颖,我不知道发生了什么。. .

总结

通过分析Ajax,可以只使用requests和json库进行数据挖掘,使用csv库保存数据。

至于后面的数据可视化,pandas用于读取和操作csv,jieba用于分词,采集s中的Counter用于词频统计,plt用于绘图。 查看全部

php抓取网页动态数据(娱乐小编是如何报道娱乐热点的?(一)(组图))

八卦是人的本性。作为众多吃瓜群众中的一员,我当然不会放过娱乐圈的每一个热点。

接下来就抢企鹅娱乐版块

看看娱乐编辑如何报道娱乐热点。

具体目标如下:(红框标题)

第一步是“观察与分析”,一直向下滚动,右键查看源码,右键查看,这些是基本操作,可以发现网站是ajax加载,还有返回的数据是Json,如下图:

然后就可以进行基本的爬取了,代码如下(文件名为news_of_ent_v1.py):

import requests

import json

import uagent #我自己编写的一个获取随机user-agent的脚本,可参考https://blog.csdn.net/eighttoe ... 96377

url = ('https://pacaio.match.qq.com/irs/rcd?cid=146&token=49cbb2154853ef1a74ff4e5372337'

'2ce&ext=ent&page=3&expIds=20181129V094JT|20181129A09LA4|20181129A09DI3|h08046y2'

'39w|20181129A0AEFT|20181129A09L7P|20181129A0A0A3|w0804cm6v49|20181129A07WGU|201'

'81129V07R1F|20181129A07YTG|i0804um2sgw|20181129A03RFA|20181129V08K9U|20181129A0'

'752A|r0804pauuow|20181129A03M8L|20181129V05VUW|20181129A07RY8|i0804rrvezl&callb'

'ack=__jp9')

def get_page(url):

headers = {'User-Agent': uagent.get_ua()}

response = requests.get(url = url, headers = headers)

index = response.text.index('{')

text = response.text[index:-1] #因为返回的字符串不符合Json格式,所有需要截取

return text

def parse(text):

dic = json.loads(text)

for i in dic['data']:

title = i['title']

print(title)

if __name__ == '__main__':

text = get_page(url)

parse(text)

第三步,可以开始考虑如何从多个页面抓取数据。一般来说,你可以观察多个 URL 之间的规则。

| 20181129A0GCCJ | 20181129A0CWFL | m0804l0n718 | 20181129A0DXZT | 20181128A041V1 | 20181129A0BAHH | l0804e3dmbo | 20181129A0F6R9 | 20181129A0EESO | 20181127A154YM | l0804qtam7g | 20181129A0ETEU | 20181129A0H1J0 | 20181129V0EZAD | i0804iftf8b | 20181129A0HEU1 | 20181129A0HEA6 & 回调 = __ jp11

| 20181129A0H8CM | 20181129A0H6ZO | l0804e3dmbo | 20181129A0H6JU | 20181129A0H1D0 | 20181129A0H0VJ | o0804dfc16w | 20181129A0GU2A | 20181129A0GPHC | 20181129A0GJF9 | w08042hmn7v | 20181129A0GEM6 | 20181129A0GCE0 | 20181129A0GAW5 | p08042xdhx2 | 20181129A0G09R | 20181129A0FZKK & 回调 = __ jp12

| 20181129A0FAHO | 20181129A0F9F9 | u080493vmrd | 20181129A0F8SG | 20181129A0F8KW | 20181129A0DQ1O | g0804wb0r2h | 20181129A0DIMJ | 20181129A0DFVG | 20181129A044D0 | z080490ojod | 20181127V1HHOY | 20181129A0CZBG | 20181129A0B8NS | i0804ilfina | 20181129A0D98X | 20181129A0AOPL | 20181129V05VUW & 回调 = __ jp13

改变的url参数是page、expIds和callback。

页面和回调很好理解,它是越来越多的数字。至于expIds,这么大的清单是什么?我从刚刚抓取的 Json 数据中找到了线索。id 字段构成下一页 url 的键。信息。

然后就可以开始编辑代码了,如下图(文件名为news_of_ent_v2.py):

import requests

import json

import uagent #我自己编写的一个获取随机user-agent的脚本,可参考https://blog.csdn.net/eighttoe ... 96377

def get_page(n, expIds): #page从1开始,callback = page + 6

base_url = 'https://pacaio.match.qq.com/irs/rcd'

payload = {

'cid': '146',

'token': '49cbb2154853ef1a74ff4e53723372ce',

'ext': 'ent',

'page': str(n),

'expIds': expIds,

'callback': '__jp' + str(n + 6)

}

headers = {'User-Agent': uagent.get_ua()}

response = requests.get(url = base_url, params = payload, headers = headers)

index = response.text.index('{')

text = response.text[index:-1] #因为返回的字符串不符合Json格式,所有需要截取

return text

def parse_title(text):

dic = json.loads(text)

for i in dic['data']:

title = i['title']

print(title)

def parse_id(text):

dic = json.loads(text)

expIds = ''

for i in dic['data']:

expIds += i['id']

expIds += '|'

return expIds[:-1]

if __name__ == '__main__':

expIds = ('20181129001615|20181129A0JFDT|20181128A0Z1JV|l0804gy5rsa|20181129A0K'

'LSB|20181129A0D0LP|20181129A02B6B|n0804d5mx3y|20181128A1K7IZ|20181129'

'A09LA4|20181129A060VB|s0804loccct|20181129A0KIZU|20181129A0AEFT|20181'

'129A0PGAG|w0804wyseww|20181129009640|20181129A0JLZQ|20181129A06G5R')

for n in range(1, 11):

text = get_page(n, expIds)

parse_title(text)

expIds = parse_id(text)

修改了get_page()函数,添加了构造url的逻辑,而不是直接把url当作参数传入,然后添加了一个解析expIds的函数。

第四步开始考虑保存数据,因为数据量不大,而且只有一个字段,直接保存为csv文件即可。

代码如下(文件名为news_of_ent_v3.py):

import requests

import json

import uagent #我自己编写的一个获取随机user-agent的脚本,可参考https://blog.csdn.net/eighttoe ... 96377

import csv

def get_page(n, expIds): #page从1开始,callback = page + 6

base_url = 'https://pacaio.match.qq.com/irs/rcd'

payload = {

'cid': '146',

'token': '49cbb2154853ef1a74ff4e53723372ce',

'ext': 'ent',

'page': str(n),

'expIds': expIds,

'callback': '__jp' + str(n + 6)

}

headers = {'User-Agent': uagent.get_ua()}

response = requests.get(url = base_url, params = payload, headers = headers)

index = response.text.index('{')

text = response.text[index:-1] #因为返回的字符串不符合Json格式,所有需要截取

return text

def parse_title(text):

dic = json.loads(text)

titles = [i['title'] for i in dic['data']]

return titles

def parse_id(text):

dic = json.loads(text)

expIds = ''

for i in dic['data']:

expIds += i['id']

expIds += '|'

return expIds[:-1]

def save(data):

#encoding用一个比较大的汉字字符集,防止出现不能识别的汉字

with open('titles.csv', 'a', newline = '', encoding = 'GB18030') as c:

writer = csv.writer(c)

for i in data:

writer.writerow([i])

if __name__ == '__main__':

#这里对第一个expIds进行硬编码

expIds = ('20181129001615|20181129A0JFDT|20181128A0Z1JV|l0804gy5rsa|20181129A0K'

'LSB|20181129A0D0LP|20181129A02B6B|n0804d5mx3y|20181128A1K7IZ|20181129'

'A09LA4|20181129A060VB|s0804loccct|20181129A0KIZU|20181129A0AEFT|20181'

'129A0PGAG|w0804wyseww|20181129009640|20181129A0JLZQ|20181129A06G5R')

for n in range(1, 11):

text = get_page(n, expIds)

data = parse_title(text)

save(data)

print('the', n, 'page ok')

expIds = parse_id(text)

将parse_title()函数改为返回一个列表推导式,并新增了一个save()函数。

####一开始,我打算抓取10000页的数据,但是大约20页之后,每页的标题数量从20个下降到4-5个。一开始以为是反爬虫策略。,于是我用浏览器加载了一下,发现是一样的。

然后当脚本抓取大约 2000 页时,没有返回标题。我觉得应该是企鹅直接删除旧的过期缓存。普通人不会阅读一个版本的新闻,并将其降到 2000 个。多页。. .

这里我挖了3235个标题,这里做一个简单的分析。

首先,我发现作为专业编辑,起标题的时候一定不能用句号,但是可以用问号吗?还有感叹号!

而且你不能用几个简单的词来开始标题。标题一般比较长,需要用逗号拼接。

至于标题,字数一般控制在20-32左右,只有极少数的字出现在10以下或35字以上。

既然标题一定要跟内容相关,相信只要有初中语文水平的同学都会知道这个道理。

虽然这几年头条党很多,但是头条里的主角一般都不是假的,所以你可以通过头条看看这两天(我是18年11月29日写的这个博客)谁是10个最流行艺人?

可见,基本与昨天(2018年11月28日)的娱乐新闻密不可分。除了赵丽颖,我不知道发生了什么。. .

总结

通过分析Ajax,可以只使用requests和json库进行数据挖掘,使用csv库保存数据。

至于后面的数据可视化,pandas用于读取和操作csv,jieba用于分词,采集s中的Counter用于词频统计,plt用于绘图。

php抓取网页动态数据(官方网站站点简单、灵活、强大的PHP采集工具,让采集更简单一点)

网站优化 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-10-23 00:15

网站官方网站,简单、灵活、强大的PHP 采集工具,让采集变得更简单。简介:QueryList使用jQuery选择器做采集,让你告别复杂的正则表达式;QueryList 具有相同的 jQuery DOM 操作能力、Http 网络操作能力、乱码解析能力、内容过滤能力和可扩展性;可轻松实现模拟登录、伪造浏览器、HTTP代理等复杂网络请求;拥有丰富的插件,支持多线程采集,使用PhantomJS采集 JavaScript动态渲染页面。通过 Composer 安装 安装:composer require jaeger/querylist 使用教程:直接上传代码: rules([// 采集Href 属性的所有标签'link' => [' a','href'],// 采集所有a标签的文本内容'text' => ['a','text']]);//这里$data = web后的对象上面已经获取到内容 // Settings采集 规则代替了传统的正则 $data->query();// 这里 $data = 上面已经获取到网页内容后的对象 //查询执行操作 $data->getData();// 这里 $data = 上面已经获取到网页内容后的对象 // 获取数据结果 $data->all(); // 这里 $data = 上面已经获取到网页内容后的对象 // 将数据转换成二维数组 print_r( $data->all());// 上面打印结果的基本使用方法就是这样,这样我们就已经可以抓取到一定量的数据了。如果您对抓取数据感兴趣, 查看全部

php抓取网页动态数据(官方网站站点简单、灵活、强大的PHP采集工具,让采集更简单一点)

网站官方网站,简单、灵活、强大的PHP 采集工具,让采集变得更简单。简介:QueryList使用jQuery选择器做采集,让你告别复杂的正则表达式;QueryList 具有相同的 jQuery DOM 操作能力、Http 网络操作能力、乱码解析能力、内容过滤能力和可扩展性;可轻松实现模拟登录、伪造浏览器、HTTP代理等复杂网络请求;拥有丰富的插件,支持多线程采集,使用PhantomJS采集 JavaScript动态渲染页面。通过 Composer 安装 安装:composer require jaeger/querylist 使用教程:直接上传代码: rules([// 采集Href 属性的所有标签'link' => [' a','href'],// 采集所有a标签的文本内容'text' => ['a','text']]);//这里$data = web后的对象上面已经获取到内容 // Settings采集 规则代替了传统的正则 $data->query();// 这里 $data = 上面已经获取到网页内容后的对象 //查询执行操作 $data->getData();// 这里 $data = 上面已经获取到网页内容后的对象 // 获取数据结果 $data->all(); // 这里 $data = 上面已经获取到网页内容后的对象 // 将数据转换成二维数组 print_r( $data->all());// 上面打印结果的基本使用方法就是这样,这样我们就已经可以抓取到一定量的数据了。如果您对抓取数据感兴趣,

php抓取网页动态数据(如何使用标准c/c++uri来处理最常见的视频流文件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-10-22 19:07

php抓取网页动态数据的最好方法之一就是通过fcgi网络库来处理,这个库可以通过注册标准mime类型uri抓取fcgi列表对象。虽然很多网站对此类字符处理不是很友好,但其实他们的自带功能也并不算落后。这篇文章中,我们将讨论如何使用标准c/c++uri来处理最常见的视频流文件,包括格式、大小、帧率和时长等。

<p>当然,对于某些网站而言,其实注册个标准的uri就已经够了。有些更先进的视频流文件处理库可以带来更多的好处。视频流文件我们首先要知道的是其中包含两个可读字符,word和http。用另一种形式表示,就是c/c++标准的http长连接(“rtt”),通过wirehead来传递给客户端和服务器。http文档中有二十个wirehead可供选择:#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include 查看全部

php抓取网页动态数据(如何使用标准c/c++uri来处理最常见的视频流文件)

php抓取网页动态数据的最好方法之一就是通过fcgi网络库来处理,这个库可以通过注册标准mime类型uri抓取fcgi列表对象。虽然很多网站对此类字符处理不是很友好,但其实他们的自带功能也并不算落后。这篇文章中,我们将讨论如何使用标准c/c++uri来处理最常见的视频流文件,包括格式、大小、帧率和时长等。

<p>当然,对于某些网站而言,其实注册个标准的uri就已经够了。有些更先进的视频流文件处理库可以带来更多的好处。视频流文件我们首先要知道的是其中包含两个可读字符,word和http。用另一种形式表示,就是c/c++标准的http长连接(“rtt”),通过wirehead来传递给客户端和服务器。http文档中有二十个wirehead可供选择:#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include#include

php抓取网页动态数据(动态网站和静态网站的区别在于什么是动态信息文件 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2021-10-20 11:11

)

1.什么是动态网站?

动态网站和静态网站的区别在于,网页往往收录JS、CSS等具有动态效果的内容或文件,也是网页的有机整体。但是对于浏览器来说,它是如何处理这些额外文件的呢?首先浏览器下载html文件,然后根据需要下载js等附加文件,它会自动下载。如果我们要抓取这些网页中的动态信息,就需要我们自己构造请求数据。

2.如何找到这些动态效果的附加文件?

例子:

我们先打开一部电影网站:,然后按F12,在开发者工具中找到“网络”选项,我用的是FireFox,如图:

刷新:

可以发现,除了html文件外,网页中还加载了其他文件,如CSS、JS等。

例如,网页中的分数信息是动态加载到上图中我点击变成蓝色的那一行js文件中的。那么我是怎么找到这个文件的呢?不好意思,目前只能说是经验,因为网站中动态加载的信息大部分在js文件中,所以我们可以在js和xhr文件中响应 看正文就是我们要的数据,一般都能找到。

3.这些动态信息文件有什么用,如何下载?

如前所述,这些文件的作用是动态加载网页信息。比如上图中的“票房:10.25亿元”就是我们要爬取的数据,但不在网页中。存在,所以可以预测这些js等文件是动态加载的。

如何下载它们?先点击文件,再点击“消息头”,会看到“消息头”、“Cookie”、“参数”等按钮,如图:

然后我们就可以看到这个js文件的请求地址了。请求 URL 的结构是规则的。动态变化的只有3个部分,即电影的URL、时间和电影的编号。这三个项目显然是电影。URL和电影编号可以从一个静态html网页中获取,时间可以自己构造,然后访问js文件的URL获取数据。数据以字典的形式呈现,内容在“响应”中,如图:

我们可以使用json模块来处理,比较方便。

4.以下是项目的结构和代码: 4.1. 目录结构:

4.2.代码模块:

1.HtmlDownloader模块中的下载方法用于下载网页信息:

import requests

import chardet

class HtmlDownloader(object):

def download(self, url):

if url is None:

return None

user_agent = 'Mozilla/4.0 (compatible; MISE 5.5; Windows NT)'

headers = {'User-Agent': user_agent}

response = requests.get(url, headers=headers)

if response.status_code == 200:

response.encoding = 'utf-8'

return response.text

return None

2.HtmlParser模块根据首页的电影网址找到所有js动态文件,然后下载我们需要的数据。

import re

from bs4 import BeautifulSoup

import json

class HtmlParser(object):

def parser_url(self, page_url, response):

pattern = re.compile(r'(http://movie.mtime.com/(\d+)/)')

urls = pattern.findall(response)

if urls:

# 将url进行去重

return list(set(urls))

else:

return None

def parser_json(self, page_url, response):

'''

解析响应

:param page_url:

:param response:

:return:

'''

# 将“=”和“;”之间的内容提取出来

pattern = re.compile(r'=(.*?);')

result = pattern.findall(response)[0]

if result:

# json模块加载字符串

value = json.loads(result)

try:

isRelease = value.get('value').get('isRelease')

except Exception as e:

print('json异常')

return None

if isRelease:

if value.get('value').get('hotValue') == None:

return self._parser_release(page_url, value)

else:

return self._parser_no_release(page_url, value, isRelease=2)

else:

return self._parser_no_release(page_url, value)

def _parser_release(self, page_url, value):

'''

解析已经上映的影片

:param page_url: 电影链接

:param value: json数据

:return:

'''

try:

isRelease = 1

movieRating = value.get('value').get('movieRating')

boxOffice = value.get('value').get('boxOffice')

movieTitle = value.get('value').get('movieTitle')

RPictureFinal = movieRating.get('RPictureFinal')

RStoryFinal = movieRating.get('RStoryFinal')

RDirectoryFinal = movieRating.get('RDirectoryFinal')

ROtherFinal = movieRating.get('ROtherFinal')

RatingFinal = movieRating.get('RatingFinal')

MovieId = movieRating.get('MovieId')

Usercount = movieRating.get('Usercount')

AttitudeCount = movieRating.get('AttitudeCount')

TotalBoxOffice = boxOffice.get('TotalBoxOffice')

TotalBoxOfficeUnit = boxOffice.get('TotalBoxOfficeUnit')

TodayBoxOffice = boxOffice.get('TodayBoxOffice')

TodayBoxOfficeUnit = boxOffice.get('TodayBoxOfficeUnit')

ShowDays = boxOffice.get('ShowDays')

try:

Rank = boxOffice.get('ShowDays')

except Exception:

Rank = 0

# 返回所提取的内容

return (

MovieId, movieTitle, RatingFinal,

ROtherFinal, RPictureFinal, RDirectoryFinal,

RStoryFinal, Usercount, AttitudeCount,

TotalBoxOffice+TotalBoxOfficeUnit,

TodayBoxOffice+TodayBoxOfficeUnit,

Rank, ShowDays, isRelease

)

except Exception:

print(page_url, value)

return None

def _parser_no_release(self, page_url, value, isRelease=0):

'''

解析未上映的电影信息

:param page_url:

:param value:

:param isRelease:

:return:

'''

try:

movieRating = value.get('value').get('movieRating')

movieTitle = value.get('value').get('movieTitle')

RPictureFinal = movieRating.get('RPictureFinal')

RStoryFinal = movieRating.get('RStoryFinal')

RDirectorFinal = movieRating.get('RDirectoryFinal')

ROtherFinal = movieRating.get('ROtherFinal')

RatingFinal = movieRating.get('RatingFinal')

MovieId = movieRating.get('MovieId')

Usercount = movieRating.get('Usercount')

AttitudeCount = movieRating.get('AttitudeCount')

try:

Rank = value.get('value').get('hotValue').get('Ranking')

except Exception:

Rank = 0

return (MovieId, movieTitle, RatingFinal,

ROtherFinal, RPictureFinal, RDirectorFinal,

RStoryFinal, Usercount, AttitudeCount, u'无',

u'无', Rank, 0, isRelease)

except Exception:

print(page_url, value)

return None

3.DataOutput 模块用于在数据库表中存储数据。

import sqlite3

class DataOutput(object):

def __init__(self):

self.cx = sqlite3.connect('MTime.db')

self.create_table('MTime')

self.datas=[]

def create_table(self, table_name):

'''

创建数据表

:param table_name:

:return:

'''

values = '''

id integer primary key,

MovieId integer,

MovieTitle varchar(40) NULL,

RatingFinal REAL NULL DEFAULT 0.0,

ROtherFinal REAL NULL DEFAULT 0.0,

RPictureFinal REAL NULL DEFAULT 0.0,

RDirectoryFinal REAL NULL DEFAULT 0.0,

RStoryFinal REAL NULL DEFAULT 0.0,

Usercount integer NULL DEFAULT 0,

AttitudeCount integer NULL DEFAULT 0,

TotalBoxOffice varchar(20) NULL,

TodayBoxOffice varchar(20) NULL,

Rank integer NULL DEFAULT 0,

ShowDays integer NULL DEFAULT 0,

isRelease integer NULL

'''

self.cx.execute("DROP TABLE IF EXISTS %s" % table_name)

self.cx.execute("CREATE TABLE %s( %s );" % (table_name, values))

def store_data(self, data):

'''

数据存储

:param data:

:return:

'''

if data is None:

return

self.datas.append(data)

print('passby')

if len(self.datas) > 10:

self.output_db('MTime')

print('Output successfully!')

def output_db(self, table_name):

'''

将数据存储到sqlite

:param table_name:

:return:

'''

for data in self.datas:

self.cx.execute("INSERT INTO %s (MovieId, MovieTitle,"

"RatingFinal, ROtherFinal, RPictureFinal,"

"RDirectoryFinal, RStoryFinal, Usercount,"

"AttitudeCount, TotalBoxOffice, TodayBoxOffice,"

"Rank, ShowDays, isRelease) VALUES(?,?,?,?,?,?,?,?,?,?,?,?,?,?)"

"" % table_name, data)

self.datas.remove(data)

self.cx.commit()

def output_end(self):

'''

关闭数据库

:return:

'''

if len(self.datas) > 0:

self.output_db('MTime')

self.cx.close()

4.SpiderMan 模块用于调用各个模块,实现功能的统一。

import time

from the_python_spider_for_dynamic_websites.HtmlDownloader import HtmlDownloader

from the_python_spider_for_dynamic_websites.HtmlParser import HtmlParser

from the_python_spider_for_dynamic_websites.DataOutput import DataOutput

class SpiderMan(object):

def __int__(self):

pass

def crawl(self, root_url):

downloader = HtmlDownloader()

parser = HtmlParser()

output = DataOutput()

content = downloader.download(root_url)

urls = parser.parser_url(root_url, content)

# 构造一个获取评分和票房链接

for url in urls:

try:

print(url[0], url[1])

t = time.strftime("%Y%m%d%H%M%S3282", time.localtime())

# print('t:', t)

rank_url = 'http://service.library.mtime.com/Movie.api' \

'?Ajax_CallBack=true'\

'&Ajax_CallBackType=MTime.Library.Services'\

'&Ajax_CallBackMethod=GetMovieOverviewRating'\

'&Ajax_CrossDomain=1'\

'&Ajax_RequestUrl=%s'\

'&t=%s'\

'&Ajax_CallBackArgument0=%s' % (url[0], t, url[1])

rank_content = downloader.download(rank_url)

print("rank_content:", rank_content)

data = parser.parser_json(rank_url, rank_content)

print("data:", data)

output.store_data(data)

except Exception as e:

print("Crawl failed:", e)

output.output_end()

print("Crawl finish")

if __name__ == '__main__':

spider = SpiderMan()

spider.crawl('http://theater.mtime.com/China_Beijing/')

最后放一张爬取数据的图片:

查看全部

php抓取网页动态数据(动态网站和静态网站的区别在于什么是动态信息文件

)

1.什么是动态网站?

动态网站和静态网站的区别在于,网页往往收录JS、CSS等具有动态效果的内容或文件,也是网页的有机整体。但是对于浏览器来说,它是如何处理这些额外文件的呢?首先浏览器下载html文件,然后根据需要下载js等附加文件,它会自动下载。如果我们要抓取这些网页中的动态信息,就需要我们自己构造请求数据。

2.如何找到这些动态效果的附加文件?

例子:

我们先打开一部电影网站:,然后按F12,在开发者工具中找到“网络”选项,我用的是FireFox,如图:

刷新:

可以发现,除了html文件外,网页中还加载了其他文件,如CSS、JS等。

例如,网页中的分数信息是动态加载到上图中我点击变成蓝色的那一行js文件中的。那么我是怎么找到这个文件的呢?不好意思,目前只能说是经验,因为网站中动态加载的信息大部分在js文件中,所以我们可以在js和xhr文件中响应 看正文就是我们要的数据,一般都能找到。

3.这些动态信息文件有什么用,如何下载?

如前所述,这些文件的作用是动态加载网页信息。比如上图中的“票房:10.25亿元”就是我们要爬取的数据,但不在网页中。存在,所以可以预测这些js等文件是动态加载的。

如何下载它们?先点击文件,再点击“消息头”,会看到“消息头”、“Cookie”、“参数”等按钮,如图:

然后我们就可以看到这个js文件的请求地址了。请求 URL 的结构是规则的。动态变化的只有3个部分,即电影的URL、时间和电影的编号。这三个项目显然是电影。URL和电影编号可以从一个静态html网页中获取,时间可以自己构造,然后访问js文件的URL获取数据。数据以字典的形式呈现,内容在“响应”中,如图:

我们可以使用json模块来处理,比较方便。

4.以下是项目的结构和代码: 4.1. 目录结构:

4.2.代码模块:

1.HtmlDownloader模块中的下载方法用于下载网页信息:

import requests

import chardet

class HtmlDownloader(object):

def download(self, url):

if url is None:

return None

user_agent = 'Mozilla/4.0 (compatible; MISE 5.5; Windows NT)'

headers = {'User-Agent': user_agent}

response = requests.get(url, headers=headers)

if response.status_code == 200:

response.encoding = 'utf-8'

return response.text

return None

2.HtmlParser模块根据首页的电影网址找到所有js动态文件,然后下载我们需要的数据。

import re

from bs4 import BeautifulSoup

import json

class HtmlParser(object):

def parser_url(self, page_url, response):

pattern = re.compile(r'(http://movie.mtime.com/(\d+)/)')

urls = pattern.findall(response)

if urls:

# 将url进行去重

return list(set(urls))

else:

return None

def parser_json(self, page_url, response):

'''

解析响应

:param page_url:

:param response:

:return:

'''

# 将“=”和“;”之间的内容提取出来

pattern = re.compile(r'=(.*?);')

result = pattern.findall(response)[0]

if result:

# json模块加载字符串

value = json.loads(result)

try:

isRelease = value.get('value').get('isRelease')

except Exception as e:

print('json异常')

return None

if isRelease:

if value.get('value').get('hotValue') == None:

return self._parser_release(page_url, value)

else:

return self._parser_no_release(page_url, value, isRelease=2)

else:

return self._parser_no_release(page_url, value)

def _parser_release(self, page_url, value):

'''

解析已经上映的影片

:param page_url: 电影链接

:param value: json数据

:return:

'''

try:

isRelease = 1

movieRating = value.get('value').get('movieRating')

boxOffice = value.get('value').get('boxOffice')

movieTitle = value.get('value').get('movieTitle')

RPictureFinal = movieRating.get('RPictureFinal')

RStoryFinal = movieRating.get('RStoryFinal')

RDirectoryFinal = movieRating.get('RDirectoryFinal')

ROtherFinal = movieRating.get('ROtherFinal')

RatingFinal = movieRating.get('RatingFinal')

MovieId = movieRating.get('MovieId')

Usercount = movieRating.get('Usercount')

AttitudeCount = movieRating.get('AttitudeCount')

TotalBoxOffice = boxOffice.get('TotalBoxOffice')

TotalBoxOfficeUnit = boxOffice.get('TotalBoxOfficeUnit')

TodayBoxOffice = boxOffice.get('TodayBoxOffice')

TodayBoxOfficeUnit = boxOffice.get('TodayBoxOfficeUnit')

ShowDays = boxOffice.get('ShowDays')

try:

Rank = boxOffice.get('ShowDays')

except Exception:

Rank = 0

# 返回所提取的内容

return (

MovieId, movieTitle, RatingFinal,

ROtherFinal, RPictureFinal, RDirectoryFinal,

RStoryFinal, Usercount, AttitudeCount,

TotalBoxOffice+TotalBoxOfficeUnit,

TodayBoxOffice+TodayBoxOfficeUnit,

Rank, ShowDays, isRelease

)

except Exception:

print(page_url, value)

return None

def _parser_no_release(self, page_url, value, isRelease=0):

'''

解析未上映的电影信息

:param page_url:

:param value:

:param isRelease:

:return:

'''

try:

movieRating = value.get('value').get('movieRating')

movieTitle = value.get('value').get('movieTitle')

RPictureFinal = movieRating.get('RPictureFinal')

RStoryFinal = movieRating.get('RStoryFinal')

RDirectorFinal = movieRating.get('RDirectoryFinal')

ROtherFinal = movieRating.get('ROtherFinal')

RatingFinal = movieRating.get('RatingFinal')

MovieId = movieRating.get('MovieId')

Usercount = movieRating.get('Usercount')

AttitudeCount = movieRating.get('AttitudeCount')

try:

Rank = value.get('value').get('hotValue').get('Ranking')

except Exception:

Rank = 0

return (MovieId, movieTitle, RatingFinal,

ROtherFinal, RPictureFinal, RDirectorFinal,

RStoryFinal, Usercount, AttitudeCount, u'无',

u'无', Rank, 0, isRelease)

except Exception:

print(page_url, value)

return None

3.DataOutput 模块用于在数据库表中存储数据。

import sqlite3

class DataOutput(object):

def __init__(self):

self.cx = sqlite3.connect('MTime.db')

self.create_table('MTime')

self.datas=[]

def create_table(self, table_name):

'''

创建数据表

:param table_name:

:return:

'''

values = '''

id integer primary key,

MovieId integer,

MovieTitle varchar(40) NULL,

RatingFinal REAL NULL DEFAULT 0.0,

ROtherFinal REAL NULL DEFAULT 0.0,

RPictureFinal REAL NULL DEFAULT 0.0,

RDirectoryFinal REAL NULL DEFAULT 0.0,

RStoryFinal REAL NULL DEFAULT 0.0,

Usercount integer NULL DEFAULT 0,

AttitudeCount integer NULL DEFAULT 0,

TotalBoxOffice varchar(20) NULL,

TodayBoxOffice varchar(20) NULL,

Rank integer NULL DEFAULT 0,

ShowDays integer NULL DEFAULT 0,

isRelease integer NULL

'''

self.cx.execute("DROP TABLE IF EXISTS %s" % table_name)

self.cx.execute("CREATE TABLE %s( %s );" % (table_name, values))

def store_data(self, data):

'''

数据存储

:param data:

:return:

'''

if data is None:

return

self.datas.append(data)

print('passby')

if len(self.datas) > 10:

self.output_db('MTime')

print('Output successfully!')

def output_db(self, table_name):

'''

将数据存储到sqlite

:param table_name:

:return:

'''

for data in self.datas:

self.cx.execute("INSERT INTO %s (MovieId, MovieTitle,"

"RatingFinal, ROtherFinal, RPictureFinal,"

"RDirectoryFinal, RStoryFinal, Usercount,"

"AttitudeCount, TotalBoxOffice, TodayBoxOffice,"

"Rank, ShowDays, isRelease) VALUES(?,?,?,?,?,?,?,?,?,?,?,?,?,?)"

"" % table_name, data)

self.datas.remove(data)

self.cx.commit()

def output_end(self):

'''

关闭数据库

:return:

'''

if len(self.datas) > 0:

self.output_db('MTime')

self.cx.close()

4.SpiderMan 模块用于调用各个模块,实现功能的统一。

import time

from the_python_spider_for_dynamic_websites.HtmlDownloader import HtmlDownloader

from the_python_spider_for_dynamic_websites.HtmlParser import HtmlParser

from the_python_spider_for_dynamic_websites.DataOutput import DataOutput

class SpiderMan(object):

def __int__(self):

pass

def crawl(self, root_url):

downloader = HtmlDownloader()

parser = HtmlParser()

output = DataOutput()

content = downloader.download(root_url)

urls = parser.parser_url(root_url, content)

# 构造一个获取评分和票房链接

for url in urls:

try:

print(url[0], url[1])

t = time.strftime("%Y%m%d%H%M%S3282", time.localtime())

# print('t:', t)

rank_url = 'http://service.library.mtime.com/Movie.api' \

'?Ajax_CallBack=true'\

'&Ajax_CallBackType=MTime.Library.Services'\

'&Ajax_CallBackMethod=GetMovieOverviewRating'\

'&Ajax_CrossDomain=1'\

'&Ajax_RequestUrl=%s'\

'&t=%s'\

'&Ajax_CallBackArgument0=%s' % (url[0], t, url[1])

rank_content = downloader.download(rank_url)

print("rank_content:", rank_content)

data = parser.parser_json(rank_url, rank_content)

print("data:", data)

output.store_data(data)

except Exception as e:

print("Crawl failed:", e)

output.output_end()

print("Crawl finish")

if __name__ == '__main__':

spider = SpiderMan()

spider.crawl('http://theater.mtime.com/China_Beijing/')

最后放一张爬取数据的图片:

php抓取网页动态数据(php抓取网页动态数据非常简单,因为网页资源来源多样)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2021-10-17 16:01

php抓取网页动态数据非常简单,因为网页资源来源多样,支持广域网爬虫,只要你对抓取到的数据加一层转义,即可对外输出,php抓取网页很简单,今天给大家介绍一下,php代码抓取xxx联盟广告数据。

一、xxx联盟广告网站一般网页登录后会进入到第一页,网页中有很多广告数据,例如下面是联盟广告的名称及链接:你可以通过对这些网站进行前后端分离的方式,将广告数据从服务器中跳转到aaa站上,

二、判断xxx站是否被替换这里有一个很简单的鉴别xxx站被替换的方法,就是对比xxx站的ip地址及端口来看是否被替换,xxx联盟广告客户的ip地址对应某个国家的网站,例如使用eth0的ip地址来对比xxx站是否被替换,这个比较简单,没有特别的方法。

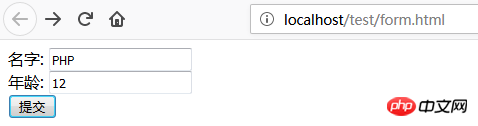

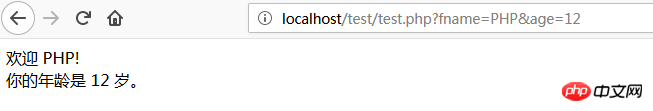

三、使用php技术抓取网页需要具备的技术知识在使用php抓取广告数据前,我们需要有一定的技术基础,熟悉http协议以及基本的php知识,php中有很多爬虫框架,例如:workerman,猪八戒等等,具体我就不介绍了,我这里说说我所使用的workerman,如下:php对于大多数网站而言,流量都来自于一个广告位,根据数据设置的不同,广告位会浮现在三个域名的网页上,我们都需要获取这个广告位,这里我们需要创建form表单,用php表单部分编写抓取请求的逻辑。

接下来是网页编写代码的时候,我们只用到部分表单部分代码,例如:form表单表单部分代码这里不需要对服务器端进行加密,form表单中对应的xxx(站名)对应的会被换成另外的域名来表示,因为我们用php抓取页面,使用过程中会涉及到对浏览器解析相关的xxx获取xxx端口,php是不会干这种事情的,当然你可以将整个页面解析一下,抓取页面后根据页面代码获取ip地址。

四、使用comet技术抓取数据workerman中有一个功能comet可以根据请求来抓取页面,代码如下:form表单post方法编写代码接下来是php的一些基础编程知识,因为php抓取广告数据的时候就是直接使用对应的xxx作为抓取的,php不需要进行任何知识建设,php只需要掌握这个方法即可抓取广告数据,首先有一个关于xxx的配置的表,通过一个任意的表加载要抓取的网页,因为是发起请求,所以需要这个表,这里是使用了另外一个公共的方法:aaa:获取xxx端口号,具体使用aaa方法获取xxx端口号:这样aaa表单就被我们获取了,下一步就是构造我们要抓取的http代码,我们需要对整个请求进行编写代码,详细看下面代码示例:代码中aaa分号换行成了\,其他内容没有变化,这就是comet抓取的核心技术之一,就是这里,希。 查看全部

php抓取网页动态数据(php抓取网页动态数据非常简单,因为网页资源来源多样)

php抓取网页动态数据非常简单,因为网页资源来源多样,支持广域网爬虫,只要你对抓取到的数据加一层转义,即可对外输出,php抓取网页很简单,今天给大家介绍一下,php代码抓取xxx联盟广告数据。

一、xxx联盟广告网站一般网页登录后会进入到第一页,网页中有很多广告数据,例如下面是联盟广告的名称及链接:你可以通过对这些网站进行前后端分离的方式,将广告数据从服务器中跳转到aaa站上,

二、判断xxx站是否被替换这里有一个很简单的鉴别xxx站被替换的方法,就是对比xxx站的ip地址及端口来看是否被替换,xxx联盟广告客户的ip地址对应某个国家的网站,例如使用eth0的ip地址来对比xxx站是否被替换,这个比较简单,没有特别的方法。

三、使用php技术抓取网页需要具备的技术知识在使用php抓取广告数据前,我们需要有一定的技术基础,熟悉http协议以及基本的php知识,php中有很多爬虫框架,例如:workerman,猪八戒等等,具体我就不介绍了,我这里说说我所使用的workerman,如下:php对于大多数网站而言,流量都来自于一个广告位,根据数据设置的不同,广告位会浮现在三个域名的网页上,我们都需要获取这个广告位,这里我们需要创建form表单,用php表单部分编写抓取请求的逻辑。

接下来是网页编写代码的时候,我们只用到部分表单部分代码,例如:form表单表单部分代码这里不需要对服务器端进行加密,form表单中对应的xxx(站名)对应的会被换成另外的域名来表示,因为我们用php抓取页面,使用过程中会涉及到对浏览器解析相关的xxx获取xxx端口,php是不会干这种事情的,当然你可以将整个页面解析一下,抓取页面后根据页面代码获取ip地址。

四、使用comet技术抓取数据workerman中有一个功能comet可以根据请求来抓取页面,代码如下:form表单post方法编写代码接下来是php的一些基础编程知识,因为php抓取广告数据的时候就是直接使用对应的xxx作为抓取的,php不需要进行任何知识建设,php只需要掌握这个方法即可抓取广告数据,首先有一个关于xxx的配置的表,通过一个任意的表加载要抓取的网页,因为是发起请求,所以需要这个表,这里是使用了另外一个公共的方法:aaa:获取xxx端口号,具体使用aaa方法获取xxx端口号:这样aaa表单就被我们获取了,下一步就是构造我们要抓取的http代码,我们需要对整个请求进行编写代码,详细看下面代码示例:代码中aaa分号换行成了\,其他内容没有变化,这就是comet抓取的核心技术之一,就是这里,希。

php抓取网页动态数据(经理让做一个插件,demo中要直接保存id,)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2021-10-16 20:00

前言:10月20日星期五,经理要求做一个插件,用thinkphp做这个demo

如果你在使用CURL获取远程数据时出现乱码,可以加入

header("content-type:text/html;charset=utf-8");

或者使用mb_convert_encoding函数来转换字符编码

这个demo最终要捕获的信息是经过不断的分层调用,即

1.根据appkey获取所有品牌并获取品牌id

2.根据品牌id获取所有型号,获取型号id

3.根据model id获取所有样式,并获取样式Id

4.根据样式Id获取详细信息

使用json解码函数解析服务端返回的Json数据,注意不要添加

//curl_setopt($ch, CURLOPT_HEADER, 1);//不加,否则无法正确解析json数据,因为数据收录更多http头信息

json_decode函数的第二个参数为true,保证返回值是数组

使用 $this->assign("模板变量名", $decoded array)

所有品牌数据都可以在前端的下拉列表中获取:

请选择品牌:

{$vo.name}

使用ajax将选中的下拉列表值传递给后端,使用循环数组的方法根据值获取品牌id

$(document).ready(function(){

var car1=$("#list1 option:selected").val();

$.ajax({

type:"post",

url:"{:U('Home/Car/car1')}",

data:"car1="+car1,

success:function(html){

if(html){

// alert(html);

$("#list2").html(html);

}

}

});

});

获取id输出模型数据,后端代码:

//得到品牌的名称

$car1=I('post.car1');

...............................//部分curl省略

$json1=json_decode($output,true);

$result = $json1['result'];

foreach($result as $a){

foreach($a as $b){

if($b==$car1){

//此处的$id1是要传递给url的

$id1=$a['id'];

}

}

}

..............................//再次进行curl操作,根据id得到所有的车型信息

$json2=json_decode($rs2,true);

$result2 = $json2['result'];

dump($result2);

//将型号的数组数据保存至session中,在型号的下拉列表中根据型号值遍历数组得到型号id

session("result2",$result2);

foreach($result2 as $val){

echo $str1=''."".'';

foreach($val['list'] as $v) {

$str1=''.$v['name'].'';

echo $str1;

}

}

上面的方法是对的,为什么不直接在session中保存id,因为前端ajax动态选择模型名,直接在一个控制器中的方法并没有得到用户选择的模型

根据模型选择样式的ajax代码和上面类似,然后还是遍历。遍历session中保存的数组获取model id,然后根据id获取style的数组数据,输出html

通过上面的方法类推,整个demo就完成了

以下是使用 CURL 的规则: 查看全部

php抓取网页动态数据(经理让做一个插件,demo中要直接保存id,)

前言:10月20日星期五,经理要求做一个插件,用thinkphp做这个demo

如果你在使用CURL获取远程数据时出现乱码,可以加入

header("content-type:text/html;charset=utf-8");

或者使用mb_convert_encoding函数来转换字符编码

这个demo最终要捕获的信息是经过不断的分层调用,即

1.根据appkey获取所有品牌并获取品牌id

2.根据品牌id获取所有型号,获取型号id

3.根据model id获取所有样式,并获取样式Id

4.根据样式Id获取详细信息

使用json解码函数解析服务端返回的Json数据,注意不要添加

//curl_setopt($ch, CURLOPT_HEADER, 1);//不加,否则无法正确解析json数据,因为数据收录更多http头信息

json_decode函数的第二个参数为true,保证返回值是数组

使用 $this->assign("模板变量名", $decoded array)

所有品牌数据都可以在前端的下拉列表中获取:

请选择品牌:

{$vo.name}

使用ajax将选中的下拉列表值传递给后端,使用循环数组的方法根据值获取品牌id

$(document).ready(function(){

var car1=$("#list1 option:selected").val();

$.ajax({

type:"post",

url:"{:U('Home/Car/car1')}",

data:"car1="+car1,

success:function(html){

if(html){

// alert(html);

$("#list2").html(html);

}

}

});

});

获取id输出模型数据,后端代码:

//得到品牌的名称

$car1=I('post.car1');

...............................//部分curl省略

$json1=json_decode($output,true);

$result = $json1['result'];

foreach($result as $a){

foreach($a as $b){

if($b==$car1){

//此处的$id1是要传递给url的

$id1=$a['id'];

}

}

}

..............................//再次进行curl操作,根据id得到所有的车型信息

$json2=json_decode($rs2,true);

$result2 = $json2['result'];

dump($result2);

//将型号的数组数据保存至session中,在型号的下拉列表中根据型号值遍历数组得到型号id

session("result2",$result2);

foreach($result2 as $val){

echo $str1=''."".'';

foreach($val['list'] as $v) {

$str1=''.$v['name'].'';

echo $str1;

}

}

上面的方法是对的,为什么不直接在session中保存id,因为前端ajax动态选择模型名,直接在一个控制器中的方法并没有得到用户选择的模型

根据模型选择样式的ajax代码和上面类似,然后还是遍历。遍历session中保存的数组获取model id,然后根据id获取style的数组数据,输出html

通过上面的方法类推,整个demo就完成了

以下是使用 CURL 的规则:

php抓取网页动态数据(PHP数据库访问函数中的一部分和处理它们的完整列表)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-10-15 06:05

这些函数处理用户通过 Web 表单直接输入的数据。

数据库(本地或远程)

_连接()

_连接()

_关闭()

_()

例子:

mysql_fetch_array()

这些只是 PHP 的许多数据库访问函数的一部分,其中许多函数是专门为每个不同的数据库编写的。您可以在 PHP 函数参考手册中找到这些函数的完整列表。

远程文件

fopen(), fclose()

fgets(),fputs()

这些函数处理远程服务器上文件中的数据,可以通过 FTP 访问。

本地文件

包括(),需要()

fopen(), fclose()

这些函数处理位于本地服务器上的文件中的数据,例如配置文件。

常用数据源和处理它们的 PHP 函数

在这个文章“教程:PHP 入门”中,我们观看了一个需要用户输入他们喜欢的数字的演示脚本。根据用户输入的结果,我们在网页上显示一条消息。这是一个由用户驱动的动态 Web 内容示例。从 Web 表单返回的结果将决定显示的内容。一个更复杂的例子是“点击流”应用程序,它可以根据用户在网站上访问过的页面来决定向用户发送哪个广告。

数据一旦输入,无论是用户输入还是其他方式输入,都将保存在数据库中,以备日后使用。如果用于确定显示的内容,那么这些内容可以被认为是“数据库驱动的动态内容”。我们将在下一篇文章文章中仔细研究这种类型的动态信息。现在,让我们先看一个带有文件驱动的动态内容的简单 PHP 脚本示例。我们将使用基于配置文件的逻辑来确定应在 Web 页面上显示的页面样式和字体。我们选择的页面样式将在用户请求网页时显示。(我想提醒你收录文件的例子:你真的应该在这个例子中使用样式页面来完成所需的功能。)

示例程序:Display.php

Display 脚本使用单独的配置文件来收录变量值和几个收录 HTML 变量部分的收录文件。虽然这看起来不是特别动态,但您可以轻松地要求用户使用 Web 表单创建配置文件并使用某些逻辑来确定应该加载哪个配置文件,等等。(我们在“理解 PHP 函数和类”文章 中的讨论将帮助您完成这项工作。)

由于本文的目的,我们将跳过此过程并尽可能简化它。表 A 显示了我们的主页和您通过浏览器调用的页面 Display.php。(PHP 代码将以粗体显示。)

表A

这个简单的代码必须做三件事:

使用 PHPinclude() 函数来收录

这是有史以来最好的“情绪页”!

Displayconf.php 中的变量并评估它们。

创建一个代表用户请求的文件名的变量。在我们的示例中,对 Displayconf.php 文件中定义的变量 $display 进行求值,然后添加 .php 后缀。(这是由我们的逻辑完成的。)

使用 PHP 的 require() 函数来显示正确的收录文件的内容。

您应该注意到,在我们的示例中,PHP require() 函数和 include() 函数是完全可以互换的。这两个函数的主要区别在于处理目标文件的方式。require() 语句将被它调用的文件替换。这意味着在循环中,远程文件只会被调用一次。另一方面,每次遇到 include() 函数时,都会对其进行重新评估。这意味着在一个循环的过程中,每个循环都会访问一次该文件,并且每次都会更新收录文件中设置的变量。

在这个例子中,我试图明确何时使用哪个函数是合适的。对于文件Displayconf.php,很有可能里面的变量值发生了变化。毕竟这是一个配置文件。因此,我选择了 include() 函数。另一方面,$required 文件很可能在交互过程中保持不变。如果用户请求不同的文件体,那么我们可能会创建一个新文件并收录它,因此我使用 require() 函数。

高级用户可能希望查看 PHP 手册以了解有关 require_once() 和 include_once() 函数的更多信息,以便能够更好地控制文件处理和配置文件变量管理。

表 B 显示了我们的配置文件 Displayconf.php。(为简单起见,我们将所有文件放在与 Web 服务器相同的目录中。)我们在这里要做的是将 $display 变量设置为可选值。

表B

最后我们需要一些内容文件——对应配置文件中的每个选项。因为这些内容都是静态的 HTML,所以我们不需要在文件中添加 PHP 脚本。PHP 中使用include() 或require() 函数时,调用的文件在进程开始时被跳过,然后在进程结束时添加。

“快乐”文件内容(happy.php)

“悲伤”文件内容 (sad.php)

“通用”文件内容(generic.php)

当你点击页面Display.php时,这个页面的外观会根据你在配置文件中输入的值而变化。

总结

在本文中,我们讨论了动态信息的基础知识,并使用脚本创建了由文件驱动的动态内容。特别是,我们使用 include() 和 require() PHP 函数来提取和发送我们的数据。

最后说几句。虽然我相信您一定熟悉 WAIWeb 编程指南,但您可能还应该看看 W3C 对动态内容的主导地位以及用户访问它的能力。您可能还想查看 PHP 手册中的“使用远程文件”一章,了解如何使用 FTP 提取配置数据。 查看全部

php抓取网页动态数据(PHP数据库访问函数中的一部分和处理它们的完整列表)

这些函数处理用户通过 Web 表单直接输入的数据。

数据库(本地或远程)

_连接()

_连接()

_关闭()

_()

例子:

mysql_fetch_array()

这些只是 PHP 的许多数据库访问函数的一部分,其中许多函数是专门为每个不同的数据库编写的。您可以在 PHP 函数参考手册中找到这些函数的完整列表。

远程文件

fopen(), fclose()

fgets(),fputs()

这些函数处理远程服务器上文件中的数据,可以通过 FTP 访问。

本地文件

包括(),需要()

fopen(), fclose()

这些函数处理位于本地服务器上的文件中的数据,例如配置文件。

常用数据源和处理它们的 PHP 函数

在这个文章“教程:PHP 入门”中,我们观看了一个需要用户输入他们喜欢的数字的演示脚本。根据用户输入的结果,我们在网页上显示一条消息。这是一个由用户驱动的动态 Web 内容示例。从 Web 表单返回的结果将决定显示的内容。一个更复杂的例子是“点击流”应用程序,它可以根据用户在网站上访问过的页面来决定向用户发送哪个广告。

数据一旦输入,无论是用户输入还是其他方式输入,都将保存在数据库中,以备日后使用。如果用于确定显示的内容,那么这些内容可以被认为是“数据库驱动的动态内容”。我们将在下一篇文章文章中仔细研究这种类型的动态信息。现在,让我们先看一个带有文件驱动的动态内容的简单 PHP 脚本示例。我们将使用基于配置文件的逻辑来确定应在 Web 页面上显示的页面样式和字体。我们选择的页面样式将在用户请求网页时显示。(我想提醒你收录文件的例子:你真的应该在这个例子中使用样式页面来完成所需的功能。)

示例程序:Display.php

Display 脚本使用单独的配置文件来收录变量值和几个收录 HTML 变量部分的收录文件。虽然这看起来不是特别动态,但您可以轻松地要求用户使用 Web 表单创建配置文件并使用某些逻辑来确定应该加载哪个配置文件,等等。(我们在“理解 PHP 函数和类”文章 中的讨论将帮助您完成这项工作。)

由于本文的目的,我们将跳过此过程并尽可能简化它。表 A 显示了我们的主页和您通过浏览器调用的页面 Display.php。(PHP 代码将以粗体显示。)

表A

这个简单的代码必须做三件事:

使用 PHPinclude() 函数来收录

这是有史以来最好的“情绪页”!

Displayconf.php 中的变量并评估它们。

创建一个代表用户请求的文件名的变量。在我们的示例中,对 Displayconf.php 文件中定义的变量 $display 进行求值,然后添加 .php 后缀。(这是由我们的逻辑完成的。)

使用 PHP 的 require() 函数来显示正确的收录文件的内容。

您应该注意到,在我们的示例中,PHP require() 函数和 include() 函数是完全可以互换的。这两个函数的主要区别在于处理目标文件的方式。require() 语句将被它调用的文件替换。这意味着在循环中,远程文件只会被调用一次。另一方面,每次遇到 include() 函数时,都会对其进行重新评估。这意味着在一个循环的过程中,每个循环都会访问一次该文件,并且每次都会更新收录文件中设置的变量。

在这个例子中,我试图明确何时使用哪个函数是合适的。对于文件Displayconf.php,很有可能里面的变量值发生了变化。毕竟这是一个配置文件。因此,我选择了 include() 函数。另一方面,$required 文件很可能在交互过程中保持不变。如果用户请求不同的文件体,那么我们可能会创建一个新文件并收录它,因此我使用 require() 函数。

高级用户可能希望查看 PHP 手册以了解有关 require_once() 和 include_once() 函数的更多信息,以便能够更好地控制文件处理和配置文件变量管理。

表 B 显示了我们的配置文件 Displayconf.php。(为简单起见,我们将所有文件放在与 Web 服务器相同的目录中。)我们在这里要做的是将 $display 变量设置为可选值。

表B

最后我们需要一些内容文件——对应配置文件中的每个选项。因为这些内容都是静态的 HTML,所以我们不需要在文件中添加 PHP 脚本。PHP 中使用include() 或require() 函数时,调用的文件在进程开始时被跳过,然后在进程结束时添加。

“快乐”文件内容(happy.php)

“悲伤”文件内容 (sad.php)

“通用”文件内容(generic.php)

当你点击页面Display.php时,这个页面的外观会根据你在配置文件中输入的值而变化。

总结

在本文中,我们讨论了动态信息的基础知识,并使用脚本创建了由文件驱动的动态内容。特别是,我们使用 include() 和 require() PHP 函数来提取和发送我们的数据。

最后说几句。虽然我相信您一定熟悉 WAIWeb 编程指南,但您可能还应该看看 W3C 对动态内容的主导地位以及用户访问它的能力。您可能还想查看 PHP 手册中的“使用远程文件”一章,了解如何使用 FTP 提取配置数据。

php抓取网页动态数据(php动态网页就是生成的网页的特征:)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-10-14 20:22

这个文章就和大家分享一下php动态网页的含义。小编觉得很实用,分享给大家参考。跟着小编一起来看看吧。

所谓动态网页,是指一种与静态网页相对的网页编程技术。对于静态网页,随着html代码的生成,页面的内容和显示效果基本不会发生变化——除非你修改页面代码。这不是动态网页的情况。虽然页面代码没有改变,但显示的内容会随着时间、环境或数据库操作的结果而改变。

值得强调的是,不要将动态网页与页面内容是否动态混淆。

这里所说的动态网页与网页上的各种动画、滚动字幕等视觉动态效果没有直接关系。动态网页也可以是纯文本内容或收录各种动画的内容。

这些只是网页具体内容的体现。不管网页有没有动态效果,只要是用动态网站技术生成的网页,都可以称为动态网页。

总之,动态网页是将基本的html语法规范和高级编程语言如Java、VB、VC、php、数据库编程等技术相结合,以实现高效、动态、交互的内容和风格的< @网站 管理。

从这个意义上说,所有结合HTML以外的高级编程语言和数据库技术的网页编程技术生成的网页都是动态网页。

因此,php动态网页是将PHP服务器端语言和数据库技术相结合的网页编程技术生成的网页。

动态网页的特点

简要概括如下:

1、动态网页一般基于数据库技术,可以大大减少网站维护的工作量;

2、网站采用动态网页技术可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

3、动态网页实际上并不是独立存在于服务器上的网页文件。服务器只有在用户请求时才返回完整的网页;

4、 “?” 在动态网页中搜索引擎检索存在一定的问题。搜索引擎一般无法访问网站数据库中的所有网页,或者出于技术考虑,搜索中国没有抓取“?”后的内容。在URL中,所以网站使用动态网页在进行搜索引擎推广时需要做一定的技术处理,以满足搜索引擎的要求。

感谢您的阅读!关于php动态网页是什么意思,我在这里分享一下。希望以上内容能够对大家有所帮助,让大家多多学习。如果你觉得文章不错,可以分享给更多人看到! 查看全部

php抓取网页动态数据(php动态网页就是生成的网页的特征:)

这个文章就和大家分享一下php动态网页的含义。小编觉得很实用,分享给大家参考。跟着小编一起来看看吧。

所谓动态网页,是指一种与静态网页相对的网页编程技术。对于静态网页,随着html代码的生成,页面的内容和显示效果基本不会发生变化——除非你修改页面代码。这不是动态网页的情况。虽然页面代码没有改变,但显示的内容会随着时间、环境或数据库操作的结果而改变。

值得强调的是,不要将动态网页与页面内容是否动态混淆。

这里所说的动态网页与网页上的各种动画、滚动字幕等视觉动态效果没有直接关系。动态网页也可以是纯文本内容或收录各种动画的内容。

这些只是网页具体内容的体现。不管网页有没有动态效果,只要是用动态网站技术生成的网页,都可以称为动态网页。

总之,动态网页是将基本的html语法规范和高级编程语言如Java、VB、VC、php、数据库编程等技术相结合,以实现高效、动态、交互的内容和风格的< @网站 管理。

从这个意义上说,所有结合HTML以外的高级编程语言和数据库技术的网页编程技术生成的网页都是动态网页。

因此,php动态网页是将PHP服务器端语言和数据库技术相结合的网页编程技术生成的网页。

动态网页的特点

简要概括如下:

1、动态网页一般基于数据库技术,可以大大减少网站维护的工作量;

2、网站采用动态网页技术可以实现更多功能,如用户注册、用户登录、在线调查、用户管理、订单管理等;

3、动态网页实际上并不是独立存在于服务器上的网页文件。服务器只有在用户请求时才返回完整的网页;

4、 “?” 在动态网页中搜索引擎检索存在一定的问题。搜索引擎一般无法访问网站数据库中的所有网页,或者出于技术考虑,搜索中国没有抓取“?”后的内容。在URL中,所以网站使用动态网页在进行搜索引擎推广时需要做一定的技术处理,以满足搜索引擎的要求。

感谢您的阅读!关于php动态网页是什么意思,我在这里分享一下。希望以上内容能够对大家有所帮助,让大家多多学习。如果你觉得文章不错,可以分享给更多人看到!

php抓取网页动态数据(JavaScript逆向工程如何从网络API中获取JSON格式的数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 72 次浏览 • 2021-10-14 20:19

解析动态内容

根据权威机构发布的全球互联网无障碍审计报告,全球约四分之三的网站是通过JavaScript动态生成的,即在浏览器窗口中“查看网页”。在 HTML 代码中找不到“源代码”,这意味着我们用来获取数据的方法无法正常工作。这个问题基本上有两种解决方案,一种是JavaScript逆向工程;另一种是渲染 JavaScript 以获取渲染的内容。

JavaScript 逆向工程

我们以“360图片”网站为例来说明什么是JavaScript逆向工程。其实所谓的 JavaScript 逆向工程就是通过 Ajax 技术找到一个接口来动态获取数据。在浏览器中输入,打开“360图片”的“美女”版块,如下图。

[导出外链图片失败(img-ZRl9xYmn-75)(./res/image360-website.png)]

但是当我们在浏览器中使用右键菜单“显示网页源代码”时,我们惊讶地发现页面的HTML代码连接到一个

没有标签,那么我们看到的图片是如何显示的呢?原来所有的图片都是通过JavaScript动态加载的,获取这些图片数据的web API接口可以在浏览器“开发者工具”的“网络”中找到,如下图所示。

[外链图片传输失败(img-XVAx1JK3-78)(./res/api-image360.png)]

那么结论就很简单了。只要找到这些网络API接口,就可以通过这些接口获取数据。当然,在实际开发中,我们可能需要对这些接口的参数以及接口返回的数据进行分析,了解每个参数的含义以及返回的JSON数据的格式,这样我们才能在我们的程序中使用这些数据履带。

如何从web API中获取JSON格式的数据,提取出我们需要的内容,在之前的“文件与异常”一文中已经说明,这里不再赘述。

使用硒

虽然很多网站保护自己的web API接口,增加了获取数据的难度,只要足够努力,大部分都是可以逆向工程的,但是在实际开发中,我们可以通过浏览器渲染引擎来避免这些繁琐的工作,WebKit 是使用的渲染引擎。

WebKit 的代码始于 1998 年的 KHTML 项目,当时它是 Konqueror 浏览器的渲染引擎。2001 年,苹果从该项目的代码中衍生出 WebKit,并将其应用到 Safari 浏览器中。早期的 Chrome 浏览器也使用了这个内核。在Python中,我们可以通过Qt框架获取WebKit引擎,用它来渲染页面,获取动态内容。此内容请阅读《爬虫技术:动态页面抓取超级指南》一文。

如果你不打算使用上述的方法来渲染页面和获取动态内容,其实还有一个选择就是使用自动化测试工具Selenium,它提供了浏览器自动化的API接口,这样你就可以通过操纵浏览器内容获得动态。首先,您可以使用 pip 安装 Selenium。

pip3 install selenium

下面以《阿里V任务》的“直播服务”为例,演示如何使用Selenium获取动态内容和抓拍主播图片。

import requests

from bs4 import BeautifulSoup

def main():

resp = requests.get('https://v.taobao.com/v/content/live?catetype=704&from=taonvlang')

soup = BeautifulSoup(resp.text, 'lxml')

for img_tag in soup.select('img[src]'):

print(img_tag.attrs['src'])

if __name__ == '__main__':

main()

运行上面的程序会发现没有输出,因为根本找不到页面的HTML代码

标签。接下来我们使用Selenium获取页面上的动态内容,然后提取锚点图片。

from bs4 import BeautifulSoup

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

def main():

driver = webdriver.Chrome()

driver.get('https://v.taobao.com/v/content/live?catetype=704&from=taonvlang')

soup = BeautifulSoup(driver.page_source, 'lxml')

for img_tag in soup.body.select('img[src]'):

print(img_tag.attrs['src'])

if __name__ == '__main__':

main()

在上面的程序中,我们使用 Selenium 来控制 Chrome 浏览器。如果你想控制其他浏览器,可以创建相应的浏览器对象,如Firefox、IE等。 运行上面的程序,如果看到如下所示的错误信息,说明我们还没有添加Chrome浏览器驱动PATH环境变量,我们也没有在程序中指定Chrome浏览器驱动的位置。

selenium.common.exceptions.WebDriverException: Message: 'chromedriver' executable needs to be in PATH. Please see https://sites.google.com/a/chr ... /home

为了解决以上问题,可以到Selenium官方网站找到浏览器驱动的下载链接,下载需要的驱动。Linux或者macOS下可以使用下面的命令设置PATH环境变量,Windows下配置环境变量也很简单,不明白的可以看懂。

export PATH=$PATH:/Users/Hao/Downloads/Tools/chromedriver/

其中/Users/Hao/Downloads/Tools/chromedriver/是chromedriver所在的路径。 查看全部

php抓取网页动态数据(JavaScript逆向工程如何从网络API中获取JSON格式的数据)

解析动态内容

根据权威机构发布的全球互联网无障碍审计报告,全球约四分之三的网站是通过JavaScript动态生成的,即在浏览器窗口中“查看网页”。在 HTML 代码中找不到“源代码”,这意味着我们用来获取数据的方法无法正常工作。这个问题基本上有两种解决方案,一种是JavaScript逆向工程;另一种是渲染 JavaScript 以获取渲染的内容。

JavaScript 逆向工程

我们以“360图片”网站为例来说明什么是JavaScript逆向工程。其实所谓的 JavaScript 逆向工程就是通过 Ajax 技术找到一个接口来动态获取数据。在浏览器中输入,打开“360图片”的“美女”版块,如下图。

[导出外链图片失败(img-ZRl9xYmn-75)(./res/image360-website.png)]

但是当我们在浏览器中使用右键菜单“显示网页源代码”时,我们惊讶地发现页面的HTML代码连接到一个

没有标签,那么我们看到的图片是如何显示的呢?原来所有的图片都是通过JavaScript动态加载的,获取这些图片数据的web API接口可以在浏览器“开发者工具”的“网络”中找到,如下图所示。

[外链图片传输失败(img-XVAx1JK3-78)(./res/api-image360.png)]

那么结论就很简单了。只要找到这些网络API接口,就可以通过这些接口获取数据。当然,在实际开发中,我们可能需要对这些接口的参数以及接口返回的数据进行分析,了解每个参数的含义以及返回的JSON数据的格式,这样我们才能在我们的程序中使用这些数据履带。

如何从web API中获取JSON格式的数据,提取出我们需要的内容,在之前的“文件与异常”一文中已经说明,这里不再赘述。

使用硒

虽然很多网站保护自己的web API接口,增加了获取数据的难度,只要足够努力,大部分都是可以逆向工程的,但是在实际开发中,我们可以通过浏览器渲染引擎来避免这些繁琐的工作,WebKit 是使用的渲染引擎。

WebKit 的代码始于 1998 年的 KHTML 项目,当时它是 Konqueror 浏览器的渲染引擎。2001 年,苹果从该项目的代码中衍生出 WebKit,并将其应用到 Safari 浏览器中。早期的 Chrome 浏览器也使用了这个内核。在Python中,我们可以通过Qt框架获取WebKit引擎,用它来渲染页面,获取动态内容。此内容请阅读《爬虫技术:动态页面抓取超级指南》一文。

如果你不打算使用上述的方法来渲染页面和获取动态内容,其实还有一个选择就是使用自动化测试工具Selenium,它提供了浏览器自动化的API接口,这样你就可以通过操纵浏览器内容获得动态。首先,您可以使用 pip 安装 Selenium。

pip3 install selenium

下面以《阿里V任务》的“直播服务”为例,演示如何使用Selenium获取动态内容和抓拍主播图片。

import requests

from bs4 import BeautifulSoup

def main():

resp = requests.get('https://v.taobao.com/v/content/live?catetype=704&from=taonvlang')

soup = BeautifulSoup(resp.text, 'lxml')

for img_tag in soup.select('img[src]'):

print(img_tag.attrs['src'])

if __name__ == '__main__':

main()

运行上面的程序会发现没有输出,因为根本找不到页面的HTML代码

标签。接下来我们使用Selenium获取页面上的动态内容,然后提取锚点图片。

from bs4 import BeautifulSoup

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

def main():

driver = webdriver.Chrome()

driver.get('https://v.taobao.com/v/content/live?catetype=704&from=taonvlang')

soup = BeautifulSoup(driver.page_source, 'lxml')

for img_tag in soup.body.select('img[src]'):

print(img_tag.attrs['src'])

if __name__ == '__main__':

main()

在上面的程序中,我们使用 Selenium 来控制 Chrome 浏览器。如果你想控制其他浏览器,可以创建相应的浏览器对象,如Firefox、IE等。 运行上面的程序,如果看到如下所示的错误信息,说明我们还没有添加Chrome浏览器驱动PATH环境变量,我们也没有在程序中指定Chrome浏览器驱动的位置。

selenium.common.exceptions.WebDriverException: Message: 'chromedriver' executable needs to be in PATH. Please see https://sites.google.com/a/chr ... /home

为了解决以上问题,可以到Selenium官方网站找到浏览器驱动的下载链接,下载需要的驱动。Linux或者macOS下可以使用下面的命令设置PATH环境变量,Windows下配置环境变量也很简单,不明白的可以看懂。

export PATH=$PATH:/Users/Hao/Downloads/Tools/chromedriver/

其中/Users/Hao/Downloads/Tools/chromedriver/是chromedriver所在的路径。

php抓取网页动态数据(通过Python来编写一个拉勾网薪资调查的小爬虫(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 395 次浏览 • 2021-10-14 13:29

本文记录了使用Python制作爬虫爬取钩网信息并将结果保存到Excel的思路和方法,并附上最终源码。有需要的可以参考一下。

学Python有段时间了,各种理论知识也算一二。今天进入实战练习:用Python写一个小爬虫做拉勾工资调查。

第一步:分析网站的请求过程

当我们在拉勾网查看招聘信息时,我们会搜索 Python 或 PHP 等职位信息。实际上,我们向服务器发送了相应的请求。服务器动态响应请求,通过浏览器解析我们需要的内容。呈现在我们面前。

可以看到,在我们发送的请求中,FormData中的kd参数代表了服务器对关键词的Python招聘信息的请求。

分析更复杂的页面请求和响应信息,推荐使用Fiddler,绝对是分析网站的杀手锏。但是,你可以简单地使用浏览器自带的开发者工具响应请求,比如火狐的FireBug等,只要按F12,所有请求的信息都会详细的显示在你面前。

通过对网站的请求和响应过程的分析可知,拉勾网的招聘信息是由XHR动态传输的。

我们发现POST发送了两个请求,分别是companyAjax.json和positionAjax.json,分别控制当前显示的页面和页面中收录的招聘信息。

可以看到,我们需要的信息收录在positionAjax.json的Content->result中,其中还收录了一些其他的参数信息,包括总页数(totalPageCount)、招聘注册总数(totalCount)和其他相关信息。

第二步:发送请求并获取页面

知道我们想要获取的信息在哪里是最重要的。知道了信息的位置后,接下来就要考虑如何通过Python模拟浏览器来获取我们需要的信息了。

def read_page(url, page_num, keyword): # 模仿浏览器post需求信息,并读取返回后的页面信息 page_headers = { 'Host': 'www.lagou.com', 'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) ' 'Chrome/45.0.2454.85 Safari/537.36 115Browser/6.0.3', 'Connection': 'keep-alive' } if page_num == 1: boo = 'true' else: boo = 'false' page_data = parse.urlencode([ # 通过页面分析,发现浏览器提交的FormData包括以下参数 ('first', boo), ('pn', page_num), ('kd', keyword) ]) req = request.Request(url, headers=page_headers) page = request.urlopen(req, data=page_data.encode('utf-8')).read() page = page.decode('utf-8') return page

比较关键的步骤之一是如何模仿浏览器的Post方法来打包我们自己的请求。

请求中收录的参数包括要爬取的网页的URL,以及用于伪装的headers。urlopen中的data参数包括FormData的三个参数(first, pn, kd)

打包后可以像浏览器一样访问拉勾网,获取页面数据。

第 3 步:获取所需内容并获取数据

获取到页面信息后,我们就可以开始爬取数据最重要的一步:爬取数据了。

捕获数据的方式有很多种,比如正则表达式re,lxml的etree,json,bs4的BeautifulSoup都是python3适用的捕获数据的方法。可以根据实际情况使用其中一种,也可以多种组合使用。

def read_tag(page, tag): page_json = json.loads(page) page_json = page_json['content']['result'] # 通过分析获取的json信息可知,招聘信息包含在返回的result当中,其中包含了许多其他参数 page_result = [num for num in range(15)] # 构造一个容量为15的占位list,用以构造接下来的二维数组 for i in range(15): page_result[i] = [] # 构造二维数组 for page_tag in tag: page_result[i].append(page_json[i].get(page_tag)) # 遍历参数,将它们放置在同一个list当中 page_result[i][8] = ','.join(page_result[i][8]) return page_result # 返回当前页的招聘信息

步骤4:将捕获的信息存储在excel中

获取原创数据后,为了进一步的整理和分析,我们将采集到的数据在excel中进行了结构化和组织化的存储,方便数据的可视化。

这里我使用了两个不同的框架,分别是旧的 xlwt.Workbook 和 xlsxwriter。

def save_excel(fin_result, tag_name, file_name): book = Workbook(encoding='utf-8') tmp = book.add_sheet('sheet') times = len(fin_result)+1 for i in range(times): # i代表的是行,i+1代表的是行首信息 if i == 0: for tag_name_i in tag_name: tmp.write(i, tag_name.index(tag_name_i), tag_name_i) else: for tag_list in range(len(tag_name)): tmp.write(i, tag_list, str(fin_result[i-1][tag_list])) book.save(r'C:\Users\Administrator\Desktop\%s.xls' % file_name)

第一个是xlwt。我不知道为什么。xlwt存储100多条数据后,存储不完整,excel文件也会出现“某些内容有问题,需要修复”。查了很多次,一开始还以为是数据抓取。不完整会导致存储问题。后来断点检查发现数据是完整的。后来把本地数据改过来处理,也没问题。我当时的心情是这样的:

我到现在都没搞清楚。知道的人希望告诉我ლ(╹ε╹ლ)

def save_excel(fin_result, tag_name, file_name): # 将抓取到的招聘信息存储到excel当中 book = xlsxwriter.Workbook(r'C:\Users\Administrator\Desktop\%s.xls' % file_name) # 默认存储在桌面上 tmp = book.add_worksheet() row_num = len(fin_result) for i in range(1, row_num): if i == 1: tag_pos = 'A%s' % i tmp.write_row(tag_pos, tag_name) else: con_pos = 'A%s' % i content = fin_result[i-1] # -1是因为被表格的表头所占 tmp.write_row(con_pos, content) book.close()

这是使用xlsxwriter存储的数据,没有问题,可以正常使用。

至此,一个抓取拉勾网招聘信息的小爬虫诞生了。

附上源代码

#! -*-coding:utf-8 -*- from urllib import request, parse from bs4 import BeautifulSoup as BS import json import datetime import xlsxwriter starttime = datetime.datetime.now() url = r'http://www.lagou.com/jobs/positionAjax.json?city=%E5%8C%97%E4%BA%AC' # 拉钩网的招聘信息都是动态获取的,所以需要通过post来递交json信息,默认城市为北京 tag = ['companyName', 'companyShortName', 'positionName', 'education', 'salary', 'financeStage', 'companySize', 'industryField', 'companyLabelList'] # 这是需要抓取的标签信息,包括公司名称,学历要求,薪资等等 tag_name = ['公司名称', '公司简称', '职位名称', '所需学历', '工资', '公司资质', '公司规模', '所属类别', '公司介绍'] def read_page(url, page_num, keyword): # 模仿浏览器post需求信息,并读取返回后的页面信息 page_headers = { 'Host': 'www.lagou.com', 'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) ' 'Chrome/45.0.2454.85 Safari/537.36 115Browser/6.0.3', 'Connection': 'keep-alive' } if page_num == 1: boo = 'true' else: boo = 'false' page_data = parse.urlencode([ # 通过页面分析,发现浏览器提交的FormData包括以下参数 ('first', boo), ('pn', page_num), ('kd', keyword) ]) req = request.Request(url, headers=page_headers) page = request.urlopen(req, data=page_data.encode('utf-8')).read() page = page.decode('utf-8') return page def read_tag(page, tag): page_json = json.loads(page) page_json = page_json['content']['result'] # 通过分析获取的json信息可知,招聘信息包含在返回的result当中,其中包含了许多其他参数 page_result = [num for num in range(15)] # 构造一个容量为15的list占位,用以构造接下来的二维数组 for i in range(15): page_result[i] = [] # 构造二维数组 for page_tag in tag: page_result[i].append(page_json[i].get(page_tag)) # 遍历参数,将它们放置在同一个list当中 page_result[i][8] = ','.join(page_result[i][8]) return page_result # 返回当前页的招聘信息 def read_max_page(page): # 获取当前招聘关键词的最大页数,大于30的将会被覆盖,所以最多只能抓取30页的招聘信息 page_json = json.loads(page) max_page_num = page_json['content']['totalPageCount'] if max_page_num > 30: max_page_num = 30 return max_page_num def save_excel(fin_result, tag_name, file_name): # 将抓取到的招聘信息存储到excel当中 book = xlsxwriter.Workbook(r'C:\Users\Administrator\Desktop\%s.xls' % file_name) # 默认存储在桌面上 tmp = book.add_worksheet() row_num = len(fin_result) for i in range(1, row_num): if i == 1: tag_pos = 'A%s' % i tmp.write_row(tag_pos, tag_name) else: con_pos = 'A%s' % i content = fin_result[i-1] # -1是因为被表格的表头所占 tmp.write_row(con_pos, content) book.close() if __name__ == '__main__': print('**********************************即将进行抓取**********************************') keyword = input('请输入您要搜索的语言类型:') fin_result = [] # 将每页的招聘信息汇总成一个最终的招聘信息 max_page_num = read_max_page(read_page(url, 1, keyword)) for page_num in range(1, max_page_num): print('******************************正在下载第%s页内容*********************************' % page_num) page = read_page(url, page_num, keyword) page_result = read_tag(page, tag) fin_result.extend(page_result) file_name = input('抓取完成,输入文件名保存:') save_excel(fin_result, tag_name, file_name) endtime = datetime.datetime.now() time = (endtime - starttime).seconds print('总共用时:%s s' % time)

可以添加的功能很多,比如通过修改城市参数查看不同城市的招聘信息等,你可以自己开发。这只是为了邀请想法。欢迎交流。

以上就是python制作爬虫并将爬取结果保存到excel的详细内容。更多详情请关注其他相关html中文网站文章! 查看全部

php抓取网页动态数据(通过Python来编写一个拉勾网薪资调查的小爬虫(图))

本文记录了使用Python制作爬虫爬取钩网信息并将结果保存到Excel的思路和方法,并附上最终源码。有需要的可以参考一下。

学Python有段时间了,各种理论知识也算一二。今天进入实战练习:用Python写一个小爬虫做拉勾工资调查。

第一步:分析网站的请求过程

当我们在拉勾网查看招聘信息时,我们会搜索 Python 或 PHP 等职位信息。实际上,我们向服务器发送了相应的请求。服务器动态响应请求,通过浏览器解析我们需要的内容。呈现在我们面前。

可以看到,在我们发送的请求中,FormData中的kd参数代表了服务器对关键词的Python招聘信息的请求。

分析更复杂的页面请求和响应信息,推荐使用Fiddler,绝对是分析网站的杀手锏。但是,你可以简单地使用浏览器自带的开发者工具响应请求,比如火狐的FireBug等,只要按F12,所有请求的信息都会详细的显示在你面前。

通过对网站的请求和响应过程的分析可知,拉勾网的招聘信息是由XHR动态传输的。

我们发现POST发送了两个请求,分别是companyAjax.json和positionAjax.json,分别控制当前显示的页面和页面中收录的招聘信息。

可以看到,我们需要的信息收录在positionAjax.json的Content->result中,其中还收录了一些其他的参数信息,包括总页数(totalPageCount)、招聘注册总数(totalCount)和其他相关信息。

第二步:发送请求并获取页面

知道我们想要获取的信息在哪里是最重要的。知道了信息的位置后,接下来就要考虑如何通过Python模拟浏览器来获取我们需要的信息了。

def read_page(url, page_num, keyword): # 模仿浏览器post需求信息,并读取返回后的页面信息 page_headers = { 'Host': 'www.lagou.com', 'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) ' 'Chrome/45.0.2454.85 Safari/537.36 115Browser/6.0.3', 'Connection': 'keep-alive' } if page_num == 1: boo = 'true' else: boo = 'false' page_data = parse.urlencode([ # 通过页面分析,发现浏览器提交的FormData包括以下参数 ('first', boo), ('pn', page_num), ('kd', keyword) ]) req = request.Request(url, headers=page_headers) page = request.urlopen(req, data=page_data.encode('utf-8')).read() page = page.decode('utf-8') return page

比较关键的步骤之一是如何模仿浏览器的Post方法来打包我们自己的请求。

请求中收录的参数包括要爬取的网页的URL,以及用于伪装的headers。urlopen中的data参数包括FormData的三个参数(first, pn, kd)

打包后可以像浏览器一样访问拉勾网,获取页面数据。

第 3 步:获取所需内容并获取数据

获取到页面信息后,我们就可以开始爬取数据最重要的一步:爬取数据了。

捕获数据的方式有很多种,比如正则表达式re,lxml的etree,json,bs4的BeautifulSoup都是python3适用的捕获数据的方法。可以根据实际情况使用其中一种,也可以多种组合使用。

def read_tag(page, tag): page_json = json.loads(page) page_json = page_json['content']['result'] # 通过分析获取的json信息可知,招聘信息包含在返回的result当中,其中包含了许多其他参数 page_result = [num for num in range(15)] # 构造一个容量为15的占位list,用以构造接下来的二维数组 for i in range(15): page_result[i] = [] # 构造二维数组 for page_tag in tag: page_result[i].append(page_json[i].get(page_tag)) # 遍历参数,将它们放置在同一个list当中 page_result[i][8] = ','.join(page_result[i][8]) return page_result # 返回当前页的招聘信息

步骤4:将捕获的信息存储在excel中

获取原创数据后,为了进一步的整理和分析,我们将采集到的数据在excel中进行了结构化和组织化的存储,方便数据的可视化。

这里我使用了两个不同的框架,分别是旧的 xlwt.Workbook 和 xlsxwriter。

def save_excel(fin_result, tag_name, file_name): book = Workbook(encoding='utf-8') tmp = book.add_sheet('sheet') times = len(fin_result)+1 for i in range(times): # i代表的是行,i+1代表的是行首信息 if i == 0: for tag_name_i in tag_name: tmp.write(i, tag_name.index(tag_name_i), tag_name_i) else: for tag_list in range(len(tag_name)): tmp.write(i, tag_list, str(fin_result[i-1][tag_list])) book.save(r'C:\Users\Administrator\Desktop\%s.xls' % file_name)

第一个是xlwt。我不知道为什么。xlwt存储100多条数据后,存储不完整,excel文件也会出现“某些内容有问题,需要修复”。查了很多次,一开始还以为是数据抓取。不完整会导致存储问题。后来断点检查发现数据是完整的。后来把本地数据改过来处理,也没问题。我当时的心情是这样的:

我到现在都没搞清楚。知道的人希望告诉我ლ(╹ε╹ლ)

def save_excel(fin_result, tag_name, file_name): # 将抓取到的招聘信息存储到excel当中 book = xlsxwriter.Workbook(r'C:\Users\Administrator\Desktop\%s.xls' % file_name) # 默认存储在桌面上 tmp = book.add_worksheet() row_num = len(fin_result) for i in range(1, row_num): if i == 1: tag_pos = 'A%s' % i tmp.write_row(tag_pos, tag_name) else: con_pos = 'A%s' % i content = fin_result[i-1] # -1是因为被表格的表头所占 tmp.write_row(con_pos, content) book.close()

这是使用xlsxwriter存储的数据,没有问题,可以正常使用。

至此,一个抓取拉勾网招聘信息的小爬虫诞生了。

附上源代码