c httpclient抓取网页

c httpclient抓取网页(网络爬虫的基本知识如何判断是否空等操做java?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-11-17 00:08

1、网络爬虫基础知识html

网络爬虫遍历互联网,抓取网络中所有相关的网页,体现了爬虫的概念。爬虫是如何穿越互联网的?互联网可以看成是一张大图,每个页面看成一个节点,页面的链接看成有向边。图的遍历方法分为宽度遍历和深度遍历,但是深度遍历可能会遍历深度过深或者掉进黑洞。因此,大多数爬虫不使用这种形式。另一方面,爬虫在按照宽度优先的方式进行遍历时,会对要遍历的网页给予一定的优先权。这称为具有偏好的遍历。

实际的爬虫从一系列种子连接开始。种子链接是起始节点,种子页面的超链接指向的页面是子节点(中间节点)。对于非html文档,如excel,无法从中提取超链接,将其视为图形的终端节点。在整个遍历过程中,会维护一个visited表,记录哪些节点(连接)被处理过,没有处理的跳过。

使用广度优先搜索策略的主要原因是:

一种。重要的网页通常靠近种子。比如我们打开新闻网站,总是最热的新闻。随着深度冲浪,网页的重要性越来越低。

湾 万维网的实际深度高达17层,但是到某个网页的路径总是很短,宽度优先遍历可以最快找到这个网页

C。宽度优先有利于多爬虫协同抓取。

2、网络爬虫的简单实现

一、定义访问队列,要访问的队列,爬取得到的URL的hash表,包括退出队列,进入队列,判断队列是否为空等,做java

package webspider;

import java.util.HashSet;

import java.util.PriorityQueue;

import java.util.Set;

import java.util.Queue;

public class LinkQueue {

// 已访问的 url 集合

private static Set visitedUrl = new HashSet();

// 待访问的 url 集合

private static Queue unVisitedUrl = new PriorityQueue();

// 得到URL队列

public static Queue getUnVisitedUrl() {

return unVisitedUrl;

}

// 添加到访问过的URL队列中

public static void addVisitedUrl(String url) {

visitedUrl.add(url);

}

// 移除访问过的URL

public static void removeVisitedUrl(String url) {

visitedUrl.remove(url);

}

// 未访问的URL出队列

public static Object unVisitedUrlDeQueue() {

return unVisitedUrl.poll();

}

// 保证每一个 url 只被访问一次

public static void addUnvisitedUrl(String url) {

if (url != null && !url.trim().equals("") && !visitedUrl.contains(url)

&& !unVisitedUrl.contains(url))

unVisitedUrl.add(url);

}

// 得到已经访问的URL数目

public static int getVisitedUrlNum() {

return visitedUrl.size();

}

// 判断未访问的URL队列中是否为空

public static boolean unVisitedUrlsEmpty() {

return unVisitedUrl.isEmpty();

}

}

二、定义DownLoadFile类,根据获取到的url抓取网页内容,下载到本地存储。这里需要引用commons-httpclient.jar、commons-codec.jar、commons-logging.jar。

package webspider;

import java.io.DataOutputStream;

import java.io.File;

import java.io.FileOutputStream;

import java.io.IOException;

import org.apache.commons.httpclient.DefaultHttpMethodRetryHandler;

import org.apache.commons.httpclient.HttpClient;

import org.apache.commons.httpclient.HttpException;

import org.apache.commons.httpclient.HttpStatus;

import org.apache.commons.httpclient.methods.GetMethod;

import org.apache.commons.httpclient.params.HttpMethodParams;

public class DownLoadFile {

/**

* 根据 url 和网页类型生成须要保存的网页的文件名 去除掉 url 中非文件名字符

*/

public String getFileNameByUrl(String url, String contentType) {

// remove http://

url = url.substring(7);

// text/html类型

if (contentType.indexOf("html") != -1) {

url = url.replaceAll("[\\?/:*|\"]", "_") + ".html";

return url;

}

// 如application/pdf类型

else {

return url.replaceAll("[\\?/:*|\"]", "_") + "."

+ contentType.substring(contentType.lastIndexOf("/") + 1);

}

}

/**

* 保存网页字节数组到本地文件 filePath 为要保存的文件的相对地址

*/

private void saveToLocal(byte[] data, String filePath) {

try {

DataOutputStream out = new DataOutputStream(new FileOutputStream(

new File(filePath)));

for (int i = 0; i < data.length; i++)

out.write(data[i]);

out.flush();

out.close();

} catch (IOException e) {

e.printStackTrace();

}

}

/* 下载 url 指向的网页 */

public String downloadFile(String url) {

String filePath = null;

/* 1.生成 HttpClinet 对象并设置参数 */

HttpClient httpClient = new HttpClient();

// 设置 Http 链接超时 5s

httpClient.getHttpConnectionManager().getParams()

.setConnectionTimeout(5000);

/* 2.生成 GetMethod 对象并设置参数 */

GetMethod getMethod = new GetMethod(url);

// 设置 get 请求超时 5s

getMethod.getParams().setParameter(HttpMethodParams.SO_TIMEOUT, 5000);

// 设置请求重试处理

getMethod.getParams().setParameter(HttpMethodParams.RETRY_HANDLER,

new DefaultHttpMethodRetryHandler());

/* 3.执行 HTTP GET 请求 */

try {

int statusCode = httpClient.executeMethod(getMethod);

// 判断访问的状态码

if (statusCode != HttpStatus.SC_OK) {

System.err.println("Method failed: "

+ getMethod.getStatusLine());

filePath = null;

}

/* 4.处理 HTTP 响应内容 */

byte[] responseBody = getMethod.getResponseBody();// 读取为字节数组

// 根据网页 url 生成保存时的文件名

filePath = "f:\\spider\\"

+ getFileNameByUrl(url,

getMethod.getResponseHeader("Content-Type")

.getValue());

saveToLocal(responseBody, filePath);

} catch (HttpException e) {

// 发生致命的异常,多是协议不对或者返回的内容有问题

System.out.println("Please check your provided http address!");

e.printStackTrace();

} catch (IOException e) {

// 发生网络异常

e.printStackTrace();

} finally {

// 释放链接

getMethod.releaseConnection();

}

return filePath;

}

}

三、定义了HtmlParserTool类,用于获取网页中的超链接(包括a标签、frame中的src等),即获取子节点的URL。需要引入htmlparser.jarnode

package webspider;

import java.util.HashSet;

import java.util.Set;

import org.htmlparser.Node;

import org.htmlparser.NodeFilter;

import org.htmlparser.Parser;

import org.htmlparser.filters.NodeClassFilter;

import org.htmlparser.filters.OrFilter;

import org.htmlparser.tags.LinkTag;

import org.htmlparser.util.NodeList;

import org.htmlparser.util.ParserException;

public class HtmlParserTool {

// 获取一个网站上的连接,filter 用来过滤连接

public static Set extracLinks(String url, LinkFilter filter) {

Set links = new HashSet();

try {

Parser parser = new Parser(url);

//parser.setEncoding("utf-8");

// 过滤 标签的 filter,用来提取 frame 标签里的 src 属性所表示的连接

NodeFilter frameFilter = new NodeFilter() {

public boolean accept(Node node) {

if (node.getText().startsWith("frame src=")) {

return true;

} else {

return false;

}

}

};

// OrFilter 来设置过滤 <a> 标签,和 标签

OrFilter linkFilter = new OrFilter(new NodeClassFilter(

LinkTag.class), frameFilter);

// 获得全部通过过滤的标签

NodeList list = parser.extractAllNodesThatMatch(linkFilter);

for (int i = 0; i < list.size(); i++) {

Node tag = list.elementAt(i);

if (tag instanceof LinkTag)// <a> 标签

{

LinkTag link = (LinkTag) tag;

String linkUrl = link.getLink();// url

if (filter.accept(linkUrl))

links.add(linkUrl);

} else// 标签

{

// 提取 frame 里 src 属性的连接如

String frame = tag.getText();

int start = frame.indexOf("src=");

frame = frame.substring(start);

int end = frame.indexOf(" ");

if (end == -1)

end = frame.indexOf(">");

String frameUrl = frame.substring(5, end - 1);

if (filter.accept(frameUrl))

links.add(frameUrl);

}

}

} catch (ParserException e) {

e.printStackTrace();

}

return links;

}

}

四、写一个测试类MyCrawler来测试爬取效果

<p>package webspider;

import java.util.Set;

public class MyCrawler {

/**

* 使用种子初始化 URL 队列

*

* @return

* @param seeds

* 种子URL

*/

private void initCrawlerWithSeeds(String[] seeds) {

for (int i = 0; i < seeds.length; i++)

LinkQueue.addUnvisitedUrl(seeds[i]);

}

/**

* 抓取过程

*

* @return

* @param seeds

*/

public void crawling(String[] seeds) { // 定义过滤器,提取以http://www.lietu.com开头的连接

LinkFilter filter = new LinkFilter() {

public boolean accept(String url) {

if (url.startsWith("http://www.baidu.com"))

return true;

else

return false;

}

};

// 初始化 URL 队列

initCrawlerWithSeeds(seeds);

// 循环条件:待抓取的连接不空且抓取的网页很少于1000

while (!LinkQueue.unVisitedUrlsEmpty()

&& LinkQueue.getVisitedUrlNum() 查看全部

c httpclient抓取网页(网络爬虫的基本知识如何判断是否空等操做java?)

1、网络爬虫基础知识html

网络爬虫遍历互联网,抓取网络中所有相关的网页,体现了爬虫的概念。爬虫是如何穿越互联网的?互联网可以看成是一张大图,每个页面看成一个节点,页面的链接看成有向边。图的遍历方法分为宽度遍历和深度遍历,但是深度遍历可能会遍历深度过深或者掉进黑洞。因此,大多数爬虫不使用这种形式。另一方面,爬虫在按照宽度优先的方式进行遍历时,会对要遍历的网页给予一定的优先权。这称为具有偏好的遍历。

实际的爬虫从一系列种子连接开始。种子链接是起始节点,种子页面的超链接指向的页面是子节点(中间节点)。对于非html文档,如excel,无法从中提取超链接,将其视为图形的终端节点。在整个遍历过程中,会维护一个visited表,记录哪些节点(连接)被处理过,没有处理的跳过。

使用广度优先搜索策略的主要原因是:

一种。重要的网页通常靠近种子。比如我们打开新闻网站,总是最热的新闻。随着深度冲浪,网页的重要性越来越低。

湾 万维网的实际深度高达17层,但是到某个网页的路径总是很短,宽度优先遍历可以最快找到这个网页

C。宽度优先有利于多爬虫协同抓取。

2、网络爬虫的简单实现

一、定义访问队列,要访问的队列,爬取得到的URL的hash表,包括退出队列,进入队列,判断队列是否为空等,做java

package webspider;

import java.util.HashSet;

import java.util.PriorityQueue;

import java.util.Set;

import java.util.Queue;

public class LinkQueue {

// 已访问的 url 集合

private static Set visitedUrl = new HashSet();

// 待访问的 url 集合

private static Queue unVisitedUrl = new PriorityQueue();

// 得到URL队列

public static Queue getUnVisitedUrl() {

return unVisitedUrl;

}

// 添加到访问过的URL队列中

public static void addVisitedUrl(String url) {

visitedUrl.add(url);

}

// 移除访问过的URL

public static void removeVisitedUrl(String url) {

visitedUrl.remove(url);

}

// 未访问的URL出队列

public static Object unVisitedUrlDeQueue() {

return unVisitedUrl.poll();

}

// 保证每一个 url 只被访问一次

public static void addUnvisitedUrl(String url) {

if (url != null && !url.trim().equals("") && !visitedUrl.contains(url)

&& !unVisitedUrl.contains(url))

unVisitedUrl.add(url);

}

// 得到已经访问的URL数目

public static int getVisitedUrlNum() {

return visitedUrl.size();

}

// 判断未访问的URL队列中是否为空

public static boolean unVisitedUrlsEmpty() {

return unVisitedUrl.isEmpty();

}

}

二、定义DownLoadFile类,根据获取到的url抓取网页内容,下载到本地存储。这里需要引用commons-httpclient.jar、commons-codec.jar、commons-logging.jar。

package webspider;

import java.io.DataOutputStream;

import java.io.File;

import java.io.FileOutputStream;

import java.io.IOException;

import org.apache.commons.httpclient.DefaultHttpMethodRetryHandler;

import org.apache.commons.httpclient.HttpClient;

import org.apache.commons.httpclient.HttpException;

import org.apache.commons.httpclient.HttpStatus;

import org.apache.commons.httpclient.methods.GetMethod;

import org.apache.commons.httpclient.params.HttpMethodParams;

public class DownLoadFile {

/**

* 根据 url 和网页类型生成须要保存的网页的文件名 去除掉 url 中非文件名字符

*/

public String getFileNameByUrl(String url, String contentType) {

// remove http://

url = url.substring(7);

// text/html类型

if (contentType.indexOf("html") != -1) {

url = url.replaceAll("[\\?/:*|\"]", "_") + ".html";

return url;

}

// 如application/pdf类型

else {

return url.replaceAll("[\\?/:*|\"]", "_") + "."

+ contentType.substring(contentType.lastIndexOf("/") + 1);

}

}

/**

* 保存网页字节数组到本地文件 filePath 为要保存的文件的相对地址

*/

private void saveToLocal(byte[] data, String filePath) {

try {

DataOutputStream out = new DataOutputStream(new FileOutputStream(

new File(filePath)));

for (int i = 0; i < data.length; i++)

out.write(data[i]);

out.flush();

out.close();

} catch (IOException e) {

e.printStackTrace();

}

}

/* 下载 url 指向的网页 */

public String downloadFile(String url) {

String filePath = null;

/* 1.生成 HttpClinet 对象并设置参数 */

HttpClient httpClient = new HttpClient();

// 设置 Http 链接超时 5s

httpClient.getHttpConnectionManager().getParams()

.setConnectionTimeout(5000);

/* 2.生成 GetMethod 对象并设置参数 */

GetMethod getMethod = new GetMethod(url);

// 设置 get 请求超时 5s

getMethod.getParams().setParameter(HttpMethodParams.SO_TIMEOUT, 5000);

// 设置请求重试处理

getMethod.getParams().setParameter(HttpMethodParams.RETRY_HANDLER,

new DefaultHttpMethodRetryHandler());

/* 3.执行 HTTP GET 请求 */

try {

int statusCode = httpClient.executeMethod(getMethod);

// 判断访问的状态码

if (statusCode != HttpStatus.SC_OK) {

System.err.println("Method failed: "

+ getMethod.getStatusLine());

filePath = null;

}

/* 4.处理 HTTP 响应内容 */

byte[] responseBody = getMethod.getResponseBody();// 读取为字节数组

// 根据网页 url 生成保存时的文件名

filePath = "f:\\spider\\"

+ getFileNameByUrl(url,

getMethod.getResponseHeader("Content-Type")

.getValue());

saveToLocal(responseBody, filePath);

} catch (HttpException e) {

// 发生致命的异常,多是协议不对或者返回的内容有问题

System.out.println("Please check your provided http address!");

e.printStackTrace();

} catch (IOException e) {

// 发生网络异常

e.printStackTrace();

} finally {

// 释放链接

getMethod.releaseConnection();

}

return filePath;

}

}

三、定义了HtmlParserTool类,用于获取网页中的超链接(包括a标签、frame中的src等),即获取子节点的URL。需要引入htmlparser.jarnode

package webspider;

import java.util.HashSet;

import java.util.Set;

import org.htmlparser.Node;

import org.htmlparser.NodeFilter;

import org.htmlparser.Parser;

import org.htmlparser.filters.NodeClassFilter;

import org.htmlparser.filters.OrFilter;

import org.htmlparser.tags.LinkTag;

import org.htmlparser.util.NodeList;

import org.htmlparser.util.ParserException;

public class HtmlParserTool {

// 获取一个网站上的连接,filter 用来过滤连接

public static Set extracLinks(String url, LinkFilter filter) {

Set links = new HashSet();

try {

Parser parser = new Parser(url);

//parser.setEncoding("utf-8");

// 过滤 标签的 filter,用来提取 frame 标签里的 src 属性所表示的连接

NodeFilter frameFilter = new NodeFilter() {

public boolean accept(Node node) {

if (node.getText().startsWith("frame src=")) {

return true;

} else {

return false;

}

}

};

// OrFilter 来设置过滤 <a> 标签,和 标签

OrFilter linkFilter = new OrFilter(new NodeClassFilter(

LinkTag.class), frameFilter);

// 获得全部通过过滤的标签

NodeList list = parser.extractAllNodesThatMatch(linkFilter);

for (int i = 0; i < list.size(); i++) {

Node tag = list.elementAt(i);

if (tag instanceof LinkTag)// <a> 标签

{

LinkTag link = (LinkTag) tag;

String linkUrl = link.getLink();// url

if (filter.accept(linkUrl))

links.add(linkUrl);

} else// 标签

{

// 提取 frame 里 src 属性的连接如

String frame = tag.getText();

int start = frame.indexOf("src=");

frame = frame.substring(start);

int end = frame.indexOf(" ");

if (end == -1)

end = frame.indexOf(">");

String frameUrl = frame.substring(5, end - 1);

if (filter.accept(frameUrl))

links.add(frameUrl);

}

}

} catch (ParserException e) {

e.printStackTrace();

}

return links;

}

}

四、写一个测试类MyCrawler来测试爬取效果

<p>package webspider;

import java.util.Set;

public class MyCrawler {

/**

* 使用种子初始化 URL 队列

*

* @return

* @param seeds

* 种子URL

*/

private void initCrawlerWithSeeds(String[] seeds) {

for (int i = 0; i < seeds.length; i++)

LinkQueue.addUnvisitedUrl(seeds[i]);

}

/**

* 抓取过程

*

* @return

* @param seeds

*/

public void crawling(String[] seeds) { // 定义过滤器,提取以http://www.lietu.com开头的连接

LinkFilter filter = new LinkFilter() {

public boolean accept(String url) {

if (url.startsWith("http://www.baidu.com";))

return true;

else

return false;

}

};

// 初始化 URL 队列

initCrawlerWithSeeds(seeds);

// 循环条件:待抓取的连接不空且抓取的网页很少于1000

while (!LinkQueue.unVisitedUrlsEmpty()

&& LinkQueue.getVisitedUrlNum()

c httpclient抓取网页(先来说下数据抓取系统的大致工作流程.下背景 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-11-10 01:02

)

公司的数据采集系统已经写了一段时间了,是时候总结一下了。否则,以我的记忆力,过一会我就会忘记。打算写个系列,记录下我踩过的所有坑。临时设置一个目录,按照这个系列写:

今天,我们来谈谈数据采集的一般工作流程。

我先说一下背景。该公司正在做企业信用报告服务。整合各个方面的数据,生成企业信用报告。主要数据来源包括:第三方采购(整体采购数据或界面形式);捕获在 Internet 上公开可用的数据。那么就需要一个数据采集平台,以便为采集方便快捷地添加新的数据对象。关于数据采集平台的架构设计,我也是新手,以后会吸取这次的经验教训。本系列从实战开始,然后是第一点:数据抓取的全过程。

我的日常数据采集分为以下几个步骤:

咳咳……先别扔鸡蛋了,我知道有人觉得这三步是我在努力做的。但是,先听我说。##清除数据采集 需要先分享一个场景:

- 产品经理:小张帅哥,我发现这个网站里面的数据对我们非常有用,你给抓取下来吧。

- 小张:好啊,你要抓取那些数据呢

- 产品经理:就这个页面的数据都要,这里的基本信息,这里的股东信息

- 小张:呃,都要是吧,好

- 产品经理:这个做好要多久啊,

- 小张:应该不会太久,这些都是表格数据,好解析

- 产品经理:好的,小张加油哦,做好了请你吃糖哦。

- 然后小张开始写,写了一会儿小张脸上冒汗了:这怎么基本信息和其他信息还不是一个页面。这表格竟然是在后台画好的,通过js请求数据画在页面的,我去,不同省份的企业表面看着一样,其实标签不一样。这要一个一个省份去适配啊啊啊啊啊啊.

- 小张同志开始加班加点,可还是没有按照和产平经理约定的时间完成任务

那么问题来了,为什么小张这么努力地加班,还没有完成任务。是不是产品经理没把需求说清楚?但是产品经理也说这个页面都是需要的。问题是:

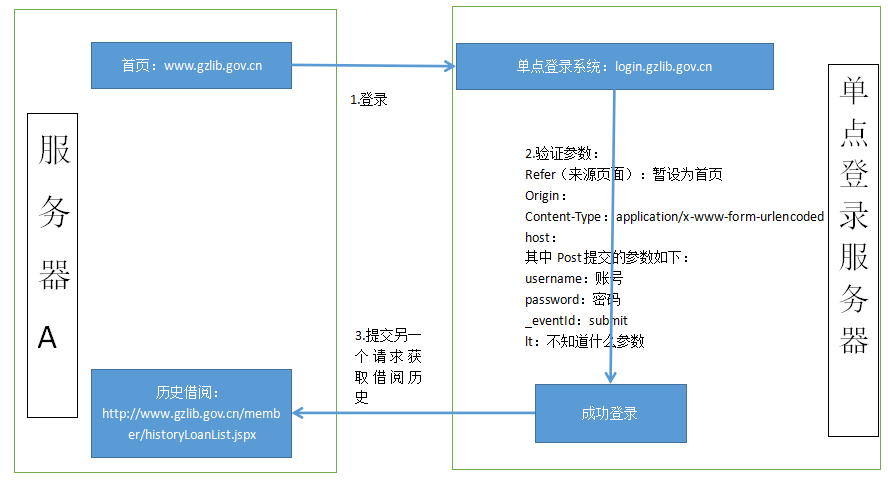

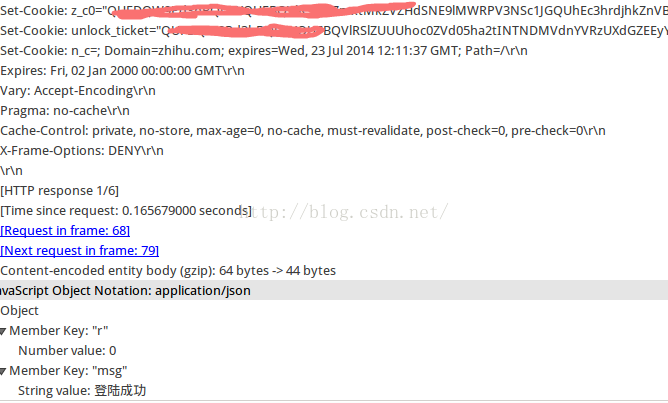

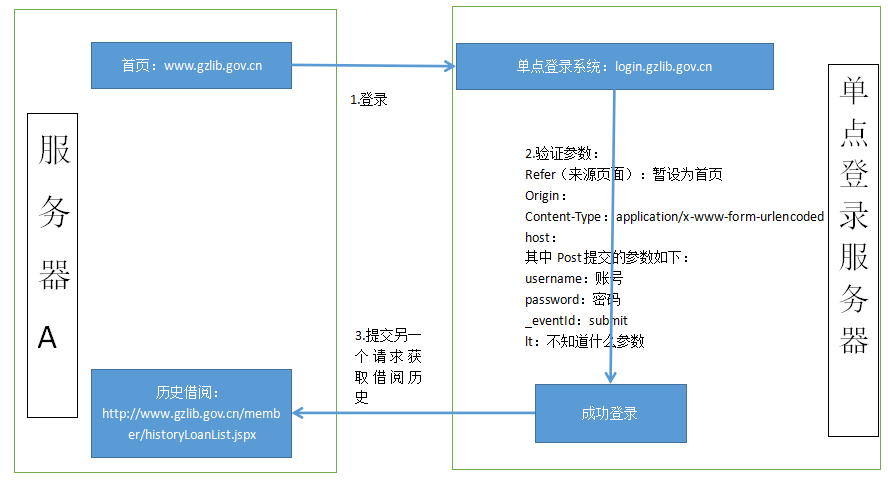

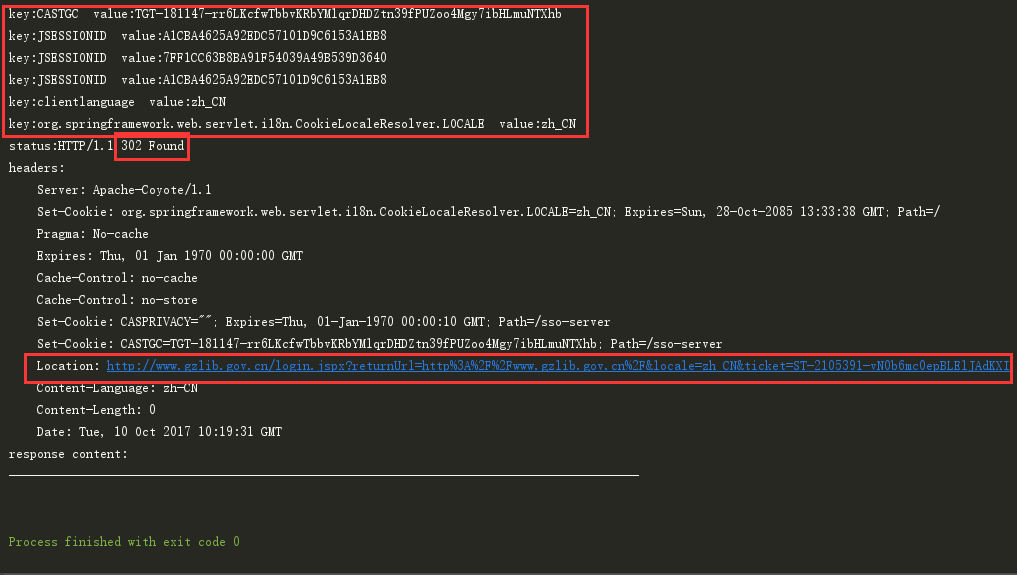

分析数据的url和相关参数要采集,我先走一遍我想爬取数据的过程,看下面四张图:

提取url和参数

从以上四张图,我们可以确定有以下连接需要处理:-1. 获取验证码connection-2。提交查询-3。查看基本注册信息页面

那么我们来看看这三个步骤的提交地址和参数。这里我们使用 Chrome 的开发者工具进行页面分析。类似的工具有很多,各个浏览器自带的开发者工具基本可以满足需求,也可以使用一些第三方插件:如firebug、httpwatch等。

编写代码实现功能

通过前面的步骤,我们已经提取出公司的基本注册信息为采集。我们需要提交三个请求,每个提交方法(POST 或 GET),以及提交的参数。下一步就是用代码实现上面的步骤,得到你想要的数据。本文文章不重复代码实现的具体逻辑,因为本文的重点是讲解:抓取网页的工作流程。后期会一一总结代码实现过程中用到的关键技术点和踩过的坑。暂时列出涉及的相关内容:

您也可以到我的个人网站查看

或者,欢迎关注我的微信订阅号,每天一个小笔记,每天进步一点点:

对公众有好处:enilu123

查看全部

c httpclient抓取网页(先来说下数据抓取系统的大致工作流程.下背景

)

公司的数据采集系统已经写了一段时间了,是时候总结一下了。否则,以我的记忆力,过一会我就会忘记。打算写个系列,记录下我踩过的所有坑。临时设置一个目录,按照这个系列写:

今天,我们来谈谈数据采集的一般工作流程。

我先说一下背景。该公司正在做企业信用报告服务。整合各个方面的数据,生成企业信用报告。主要数据来源包括:第三方采购(整体采购数据或界面形式);捕获在 Internet 上公开可用的数据。那么就需要一个数据采集平台,以便为采集方便快捷地添加新的数据对象。关于数据采集平台的架构设计,我也是新手,以后会吸取这次的经验教训。本系列从实战开始,然后是第一点:数据抓取的全过程。

我的日常数据采集分为以下几个步骤:

咳咳……先别扔鸡蛋了,我知道有人觉得这三步是我在努力做的。但是,先听我说。##清除数据采集 需要先分享一个场景:

- 产品经理:小张帅哥,我发现这个网站里面的数据对我们非常有用,你给抓取下来吧。

- 小张:好啊,你要抓取那些数据呢

- 产品经理:就这个页面的数据都要,这里的基本信息,这里的股东信息

- 小张:呃,都要是吧,好

- 产品经理:这个做好要多久啊,

- 小张:应该不会太久,这些都是表格数据,好解析

- 产品经理:好的,小张加油哦,做好了请你吃糖哦。

- 然后小张开始写,写了一会儿小张脸上冒汗了:这怎么基本信息和其他信息还不是一个页面。这表格竟然是在后台画好的,通过js请求数据画在页面的,我去,不同省份的企业表面看着一样,其实标签不一样。这要一个一个省份去适配啊啊啊啊啊啊.

- 小张同志开始加班加点,可还是没有按照和产平经理约定的时间完成任务

那么问题来了,为什么小张这么努力地加班,还没有完成任务。是不是产品经理没把需求说清楚?但是产品经理也说这个页面都是需要的。问题是:

分析数据的url和相关参数要采集,我先走一遍我想爬取数据的过程,看下面四张图:

提取url和参数

从以上四张图,我们可以确定有以下连接需要处理:-1. 获取验证码connection-2。提交查询-3。查看基本注册信息页面

那么我们来看看这三个步骤的提交地址和参数。这里我们使用 Chrome 的开发者工具进行页面分析。类似的工具有很多,各个浏览器自带的开发者工具基本可以满足需求,也可以使用一些第三方插件:如firebug、httpwatch等。

编写代码实现功能

通过前面的步骤,我们已经提取出公司的基本注册信息为采集。我们需要提交三个请求,每个提交方法(POST 或 GET),以及提交的参数。下一步就是用代码实现上面的步骤,得到你想要的数据。本文文章不重复代码实现的具体逻辑,因为本文的重点是讲解:抓取网页的工作流程。后期会一一总结代码实现过程中用到的关键技术点和踩过的坑。暂时列出涉及的相关内容:

您也可以到我的个人网站查看

或者,欢迎关注我的微信订阅号,每天一个小笔记,每天进步一点点:

对公众有好处:enilu123

c httpclient抓取网页(最简单的爬虫,不需要设定代理服务器,怎么办? )

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2021-11-05 12:16

)

最简单的爬虫不需要设置代理服务器,不需要设置cookie,不需要设置http连接池,使用httpget方法,只需要获取html代码...

嗯,满足这个要求的爬虫应该就是最基础的爬虫了。当然,这也是复杂爬虫的基础。

使用了httpclient4的相关API。别跟我说网上有很多httpclient3代码兼容性问题,都没有太大区别,但是我们应该选择一个可以使用的新接口!

当然还有很多细节需要注意,比如编码问题(我一般强制UTF-8)

毕业:

import java.io.ByteArrayOutputStream;

import java.io.IOException;

import java.io.InputStream;

import org.apache.http.HttpEntity;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

public class Easy {

//输入流转为String类型

public static String inputStream2String(InputStream is)throws IOException{

ByteArrayOutputStream baos=new ByteArrayOutputStream();

int i=-1;

while((i=is.read())!=-1){

baos.write(i);

}

return baos.toString();

}

//抓取网页的核心函数

public static void doGrab() throws Exception {

//httpclient可以认为是模拟的浏览器

CloseableHttpClient httpclient = HttpClients.createDefault();

try {

//要访问的目标页面url

String targetUrl="http://chriszz.sinaapp.com";

//使用get方式请求页面。复杂一点也可以换成post方式的

HttpGet httpGet = new HttpGet(targetUrl);

CloseableHttpResponse response1 = httpclient.execute(httpGet);

try {

String status=response1.getStatusLine().toString();

//通过状态码来判断访问是否正常。200表示抓取成功

if(!status.equals("HTTP/1.1 200 OK")){

System.out.println("此页面可以正常获取!");

}else{

response1 = httpclient.execute(httpGet);

System.out.println(status);

}

//System.out.println(response1.getStatusLine());

HttpEntity entity1 = response1.getEntity();

// do something useful with the response body

// and ensure it is fully consumed

InputStream input=entity1.getContent();

String rawHtml=inputStream2String(input);

System.out.println(rawHtml);

//有时候会有中文乱码问题,这取决于你的eclipse java工程设定的编码格式、当前java文件的编码格式,以及抓取的网页的编码格式

//比如,你可以用String的getBytes()转换编码

//String html = new String(rawHtml.getBytes("ISO-8859-1"),"UTF-8");//转换后的结果

EntityUtils.consume(entity1);

} finally {

response1.close();//记得要关闭

}

} finally {

httpclient.close();//这个也要关闭哦!

}

}

/*

* 最简单的java爬虫--抓取百度首页

* memo:

* 0.抓取的是百度的首页,对应一个html页面。

* (至于为啥我们访问的是http://www.baidu.com而不是http://www.baidu.com/xxx.html,这个是百度那边设定的,总之我们会访问到那个包含html的页面)

* 1.使用http协议的get方法就可以了(以后复杂了可以用post方法,设定cookie,甚至设定http连接池;或者抓取json格式的数据、抓取图片等,也是类似的)

* 2.通过httpclient的相关包(httpclient4版本)编写,需要下载并添加相应的jar包到build path中

* 3.代码主要参考了httpclient(http://hc.apache.org/)包里面的tutorial的pdf文件。

*/

public static void main(String[] args) throws Exception{

Easy.doGrab();//为了简答这里把doGrab()方法定义为静态方法了所以直接Easy.doGrab()就好了

}

} 查看全部

c httpclient抓取网页(最简单的爬虫,不需要设定代理服务器,怎么办?

)

最简单的爬虫不需要设置代理服务器,不需要设置cookie,不需要设置http连接池,使用httpget方法,只需要获取html代码...

嗯,满足这个要求的爬虫应该就是最基础的爬虫了。当然,这也是复杂爬虫的基础。

使用了httpclient4的相关API。别跟我说网上有很多httpclient3代码兼容性问题,都没有太大区别,但是我们应该选择一个可以使用的新接口!

当然还有很多细节需要注意,比如编码问题(我一般强制UTF-8)

毕业:

import java.io.ByteArrayOutputStream;

import java.io.IOException;

import java.io.InputStream;

import org.apache.http.HttpEntity;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

public class Easy {

//输入流转为String类型

public static String inputStream2String(InputStream is)throws IOException{

ByteArrayOutputStream baos=new ByteArrayOutputStream();

int i=-1;

while((i=is.read())!=-1){

baos.write(i);

}

return baos.toString();

}

//抓取网页的核心函数

public static void doGrab() throws Exception {

//httpclient可以认为是模拟的浏览器

CloseableHttpClient httpclient = HttpClients.createDefault();

try {

//要访问的目标页面url

String targetUrl="http://chriszz.sinaapp.com";

//使用get方式请求页面。复杂一点也可以换成post方式的

HttpGet httpGet = new HttpGet(targetUrl);

CloseableHttpResponse response1 = httpclient.execute(httpGet);

try {

String status=response1.getStatusLine().toString();

//通过状态码来判断访问是否正常。200表示抓取成功

if(!status.equals("HTTP/1.1 200 OK")){

System.out.println("此页面可以正常获取!");

}else{

response1 = httpclient.execute(httpGet);

System.out.println(status);

}

//System.out.println(response1.getStatusLine());

HttpEntity entity1 = response1.getEntity();

// do something useful with the response body

// and ensure it is fully consumed

InputStream input=entity1.getContent();

String rawHtml=inputStream2String(input);

System.out.println(rawHtml);

//有时候会有中文乱码问题,这取决于你的eclipse java工程设定的编码格式、当前java文件的编码格式,以及抓取的网页的编码格式

//比如,你可以用String的getBytes()转换编码

//String html = new String(rawHtml.getBytes("ISO-8859-1"),"UTF-8");//转换后的结果

EntityUtils.consume(entity1);

} finally {

response1.close();//记得要关闭

}

} finally {

httpclient.close();//这个也要关闭哦!

}

}

/*

* 最简单的java爬虫--抓取百度首页

* memo:

* 0.抓取的是百度的首页,对应一个html页面。

* (至于为啥我们访问的是http://www.baidu.com而不是http://www.baidu.com/xxx.html,这个是百度那边设定的,总之我们会访问到那个包含html的页面)

* 1.使用http协议的get方法就可以了(以后复杂了可以用post方法,设定cookie,甚至设定http连接池;或者抓取json格式的数据、抓取图片等,也是类似的)

* 2.通过httpclient的相关包(httpclient4版本)编写,需要下载并添加相应的jar包到build path中

* 3.代码主要参考了httpclient(http://hc.apache.org/)包里面的tutorial的pdf文件。

*/

public static void main(String[] args) throws Exception{

Easy.doGrab();//为了简答这里把doGrab()方法定义为静态方法了所以直接Easy.doGrab()就好了

}

}

c httpclient抓取网页(cookies设置.UseCookies=(默认为true),默认的会自己带上cookies)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-10-30 09:05

通过设置handler.UseCookies=true(默认为true),默认会自带cookies

var handler = new HttpClientHandler() { UseCookies = true };

var client = new HttpClient(handler);// { BaseAddress = baseAddress };

client.DefaultRequestHeaders.Add("user-agent", "Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:57.0) Gecko/20200101 Firefox/57.0");

client.DefaultRequestHeaders.Add("Connection", "Keep-Alive");

client.DefaultRequestHeaders.Add("Keep-Alive", "timeout=900");

var content = new FormUrlEncodedContent(new[]

{

new KeyValuePair("email", "xj"),

new KeyValuePair("password", "a"),

});

var result = await client.PostAsync("https://www.xxjj.com/login/login", content);

result.EnsureSuccessStatusCode();

这种情况下,post请求登录成功后,会跳转到另一个页面,cookies也会自动带上。如果handler.UseCookies设置为false,登录后重定向不会自动带cookies,会跳转到登录页面。

该方法的使用场景:抓取需要登录的网页数据,不设置任何cookies,httpclient登录后会自动将cookies放入后续请求中。

但也要注意,如果你只是直接发起一个请求,它不会传递被发起项目本身的cookie信息,它会带上你请求的cookie网站 查看全部

c httpclient抓取网页(cookies设置.UseCookies=(默认为true),默认的会自己带上cookies)

通过设置handler.UseCookies=true(默认为true),默认会自带cookies

var handler = new HttpClientHandler() { UseCookies = true };

var client = new HttpClient(handler);// { BaseAddress = baseAddress };

client.DefaultRequestHeaders.Add("user-agent", "Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:57.0) Gecko/20200101 Firefox/57.0");

client.DefaultRequestHeaders.Add("Connection", "Keep-Alive");

client.DefaultRequestHeaders.Add("Keep-Alive", "timeout=900");

var content = new FormUrlEncodedContent(new[]

{

new KeyValuePair("email", "xj"),

new KeyValuePair("password", "a"),

});

var result = await client.PostAsync("https://www.xxjj.com/login/login", content);

result.EnsureSuccessStatusCode();

这种情况下,post请求登录成功后,会跳转到另一个页面,cookies也会自动带上。如果handler.UseCookies设置为false,登录后重定向不会自动带cookies,会跳转到登录页面。

该方法的使用场景:抓取需要登录的网页数据,不设置任何cookies,httpclient登录后会自动将cookies放入后续请求中。

但也要注意,如果你只是直接发起一个请求,它不会传递被发起项目本身的cookie信息,它会带上你请求的cookie网站

c httpclient抓取网页(java语言下一个支持http协议的登录意义是什么?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-10-30 00:19

介绍

HttpClient是Java语言下支持HTTP协议的客户端编程工具包。它实现了HTTP协议的所有方法,但不支持JS渲染。我们在做一些小工具的时候,可能需要登录一些网站来获取信息,那么HttpClient就是你的好帮手,废话不多说,进入实战。

登录的实际意义

在HTTP泛滥的今天,我们每天都要登录一些网站,那么登录有什么意义呢?首先,我们必须对cookies有一定的了解。Cookie 是存储在本地的小文件。服务器发送命令,浏览器在本地读写。在访问某些网站时,浏览器会检查是否有网站的cookie信息。如果有,在发送访问请求时会携带这些内容,服务器可以读取到浏览器。在请求中发送cookie信息,然后在响应请求时写入cookie信息。Cookie信息包括键值、内容、过期时间、归属网站。

说到cookies,我就快做完了,那登录有什么问题呢?登录意味着服务器将 cookie 写入您的浏览器。如果你只是在你的电脑上写了一个cookie,别有用心的人伪造cookie也可能有机会登录网站,所以服务器会在内存中保留一份相同的信息,这个过程叫做一个对话。如果点击网站中的注销按钮,服务器会清除内存中的cookies,也会清除浏览器中与登录相关的cookies。知道了这一点,我们就可以开始了。

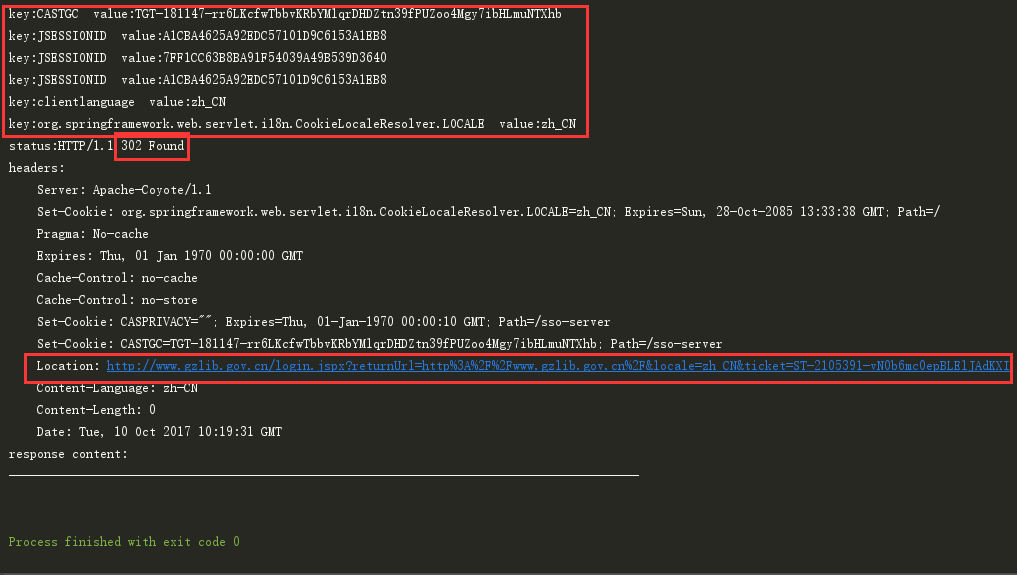

二 找到登录密钥cookie

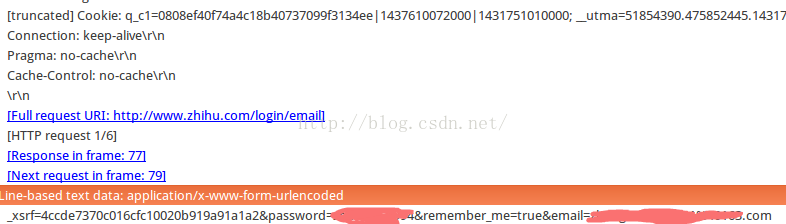

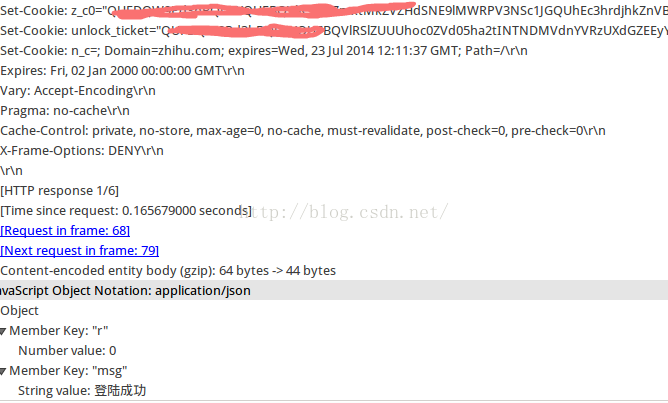

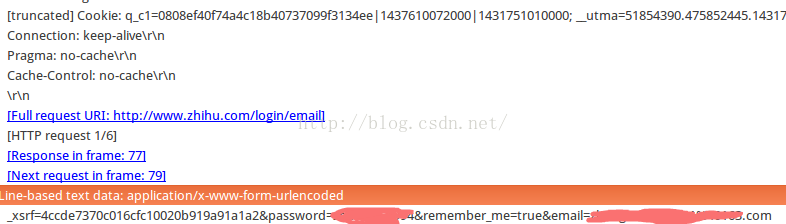

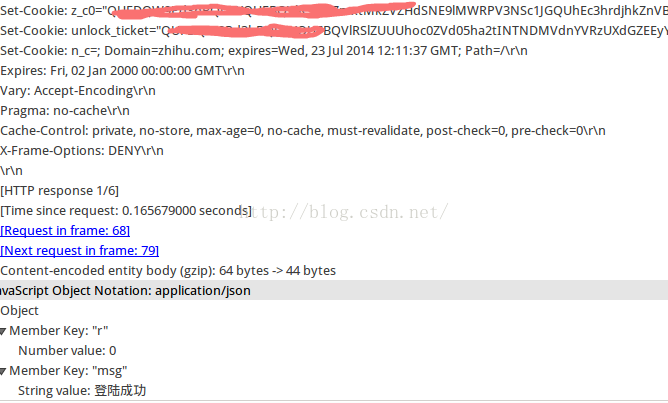

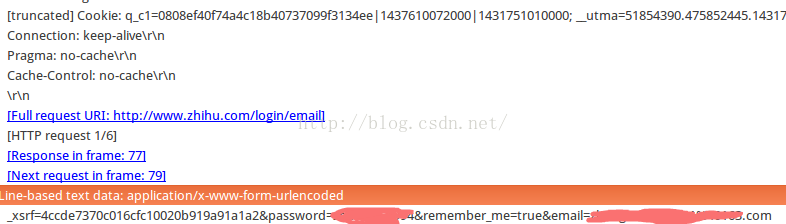

这里我们可以使用wireshark来抓包分析。打开知乎的首页,打开wireshark,开始监听端口,输入用户名和密码,点击login查看wireshark抓到的数据包。截图如下:

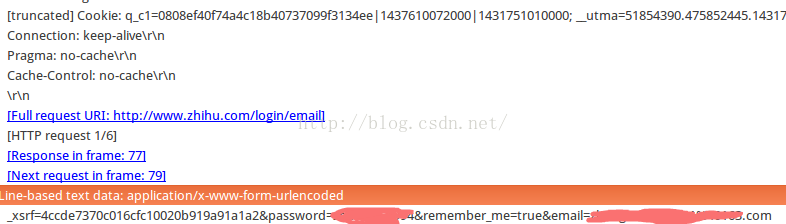

第一张图是本地post提交数据。

第二张图是提交的信息,包括_xsrf、密码、remember_me、email。注意提交的信息包括cookies,_xsrf可以从知乎的主页获取。

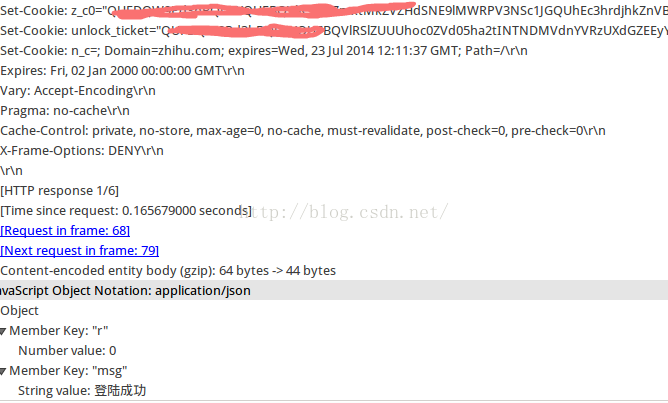

第三张图是服务器返回的信息。请注意,其状态为 200,表示成功。

第4章的图是服务器返回的数据。请注意,它具有三个 cookie 设置和一条指示登录是否成功的消息。

通过上面的步骤我们可以知道什么?一是发送登录请求时的cookie和post数据格式,二是可以获取登录的cookie信息(第四张图)。 查看全部

c httpclient抓取网页(java语言下一个支持http协议的登录意义是什么?)

介绍

HttpClient是Java语言下支持HTTP协议的客户端编程工具包。它实现了HTTP协议的所有方法,但不支持JS渲染。我们在做一些小工具的时候,可能需要登录一些网站来获取信息,那么HttpClient就是你的好帮手,废话不多说,进入实战。

登录的实际意义

在HTTP泛滥的今天,我们每天都要登录一些网站,那么登录有什么意义呢?首先,我们必须对cookies有一定的了解。Cookie 是存储在本地的小文件。服务器发送命令,浏览器在本地读写。在访问某些网站时,浏览器会检查是否有网站的cookie信息。如果有,在发送访问请求时会携带这些内容,服务器可以读取到浏览器。在请求中发送cookie信息,然后在响应请求时写入cookie信息。Cookie信息包括键值、内容、过期时间、归属网站。

说到cookies,我就快做完了,那登录有什么问题呢?登录意味着服务器将 cookie 写入您的浏览器。如果你只是在你的电脑上写了一个cookie,别有用心的人伪造cookie也可能有机会登录网站,所以服务器会在内存中保留一份相同的信息,这个过程叫做一个对话。如果点击网站中的注销按钮,服务器会清除内存中的cookies,也会清除浏览器中与登录相关的cookies。知道了这一点,我们就可以开始了。

二 找到登录密钥cookie

这里我们可以使用wireshark来抓包分析。打开知乎的首页,打开wireshark,开始监听端口,输入用户名和密码,点击login查看wireshark抓到的数据包。截图如下:

第一张图是本地post提交数据。

第二张图是提交的信息,包括_xsrf、密码、remember_me、email。注意提交的信息包括cookies,_xsrf可以从知乎的主页获取。

第三张图是服务器返回的信息。请注意,其状态为 200,表示成功。

第4章的图是服务器返回的数据。请注意,它具有三个 cookie 设置和一条指示登录是否成功的消息。

通过上面的步骤我们可以知道什么?一是发送登录请求时的cookie和post数据格式,二是可以获取登录的cookie信息(第四张图)。

c httpclient抓取网页(Android应用程序使用HttpClient即可访问被保护页而了吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-10-29 08:20

例如,Android 应用程序需要向指定页面发送请求,但该页面不是简单的页面。只有当用户已经登录并且登录用户的用户名有效时,才能访问该页面。如果使用HttpURLConnection访问这个受保护的页面,需要处理的细节太复杂了。

其实,在web应用中访问受保护的页面,使用浏览器是非常简单的。用户通过系统提供的登录页面登录系统,浏览器负责维护与服务器的Session。如果用户登录用户名和密码符合要求,您就可以访问受保护的资源。

在 Android 应用中,您可以使用 HttpClient 登录系统。只要应用使用同一个HttpClient发送请求,HttpClient就会自动与服务器保持Session状态。也就是说,程序第一次使用HttpClient登录系统。然后使用 HttpClient 访问受保护的页面。

总结:在Android开发中,虽然HttpClient更好的支持了很多细节控件(比如代理、cookie、认证、压缩、连接池),但是对开发者的要求更高,而且代码写起来也比较复杂,普通开发难度大人员管理好,官方支持越来越少;而 HttpUrlConnection 包裹了大部分工作,屏蔽了不必要的细节,更适合开发者直接调用,官方对它的支持和优化也会越来越好。既然是开发Android应用,自然要遵循Android官方的指导方针,选择HttpUrlConnection。 查看全部

c httpclient抓取网页(Android应用程序使用HttpClient即可访问被保护页而了吗?)

例如,Android 应用程序需要向指定页面发送请求,但该页面不是简单的页面。只有当用户已经登录并且登录用户的用户名有效时,才能访问该页面。如果使用HttpURLConnection访问这个受保护的页面,需要处理的细节太复杂了。

其实,在web应用中访问受保护的页面,使用浏览器是非常简单的。用户通过系统提供的登录页面登录系统,浏览器负责维护与服务器的Session。如果用户登录用户名和密码符合要求,您就可以访问受保护的资源。

在 Android 应用中,您可以使用 HttpClient 登录系统。只要应用使用同一个HttpClient发送请求,HttpClient就会自动与服务器保持Session状态。也就是说,程序第一次使用HttpClient登录系统。然后使用 HttpClient 访问受保护的页面。

总结:在Android开发中,虽然HttpClient更好的支持了很多细节控件(比如代理、cookie、认证、压缩、连接池),但是对开发者的要求更高,而且代码写起来也比较复杂,普通开发难度大人员管理好,官方支持越来越少;而 HttpUrlConnection 包裹了大部分工作,屏蔽了不必要的细节,更适合开发者直接调用,官方对它的支持和优化也会越来越好。既然是开发Android应用,自然要遵循Android官方的指导方针,选择HttpUrlConnection。

c httpclient抓取网页(我正在尝试使用C#和ChromeWebInspector登录并在)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-10-28 07:11

问题

我正在尝试使用 C# 和 Chrome Web Inspector 登录并进入。

我不太了解人们必须用来解释 Web Inspector 中的信息以模拟登录和模拟维护会话并导航到下一页以采集信息的心理过程。

有人可以向我解释或指点我吗?

目前,我只有一些代码来获取主页和登录页面的内容:

公共类Morningstar

{

公共异步静态无效Ru4n()

{

var url =" http://www.morningstar.com/";

var httpClient = new HttpClient();

httpClient.DefaultRequestHeaders.TryAddWithoutValidation(" Accept"," text / html,application / xhtml + xml,application / xml");

httpClient.DefaultRequestHeaders.TryAddWithoutValidation(" Accept-Encoding"," gzip,deflate");

httpClient.DefaultRequestHeaders.TryAddWithoutValidation(" User-Agent"," Mozilla / 5.0(Windows NT 6.2; WOW64; rv:19.0)Gecko / 20100101 Firefox / 19.0");

httpClient.DefaultRequestHeaders.TryAddWithoutValidation(" Accept-Charset"," ISO-8859-1");

var response = await httpClient.GetAsync(new Uri(url));

response.EnsureSuccessStatusCode();

使用(var responseStream =等待response.Content.ReadAsStreamAsync())

使用(var decompressedStream = new GZipStream(responseStream,CompressionMode.Decompress))

使用(var streamReader = new StreamReader(decompressedStream) ))

{

//Console.WriteLine(streamReader.ReadToEnd());

}

var loginURL =" https://members.morningstar.co ... 3B%3B

response =等待httpClient.GetAsync(new Uri(loginURL));

response.EnsureSuccessStatusCode();

使用(var responseStream =等待response.Content.ReadAsStreamAsync())

使用(var streamReader = new StreamReader(responseStream))

{

Console.WriteLine(streamReader.ReadToEnd( ));

}

}

编辑:最后,按照穆罕默德的建议,我使用了以下代码:

ScrapingBrowser浏览器= new ScrapingBrowser();

//如果网站返回的cookie格式无效,则将UseDefaultCookiesParser设置为false

//browser.UseDefaultCookiesParser = false;

网页主页=浏览器。NavigateToPage(新Uri(" https://members.morningstar.co ... ot%3B));

PageWebForm form = homePage.FindFormById(" memberLoginForm");

form [" email_textbox"] =" example@example.com";

form [" pwd_textbox"] ="密码";

form [" go_button.x"] =" 57";

form [" go_button.y"] =" 22";

form.Method = HttpVerb.Post;

WebPage resultsPage = form.Submit();

解决方案

你应该模拟网站的登录过程。最简单的方法是通过一些调试器(如 Fiddler)检查 网站。

以下是网站的登录请求:

POST https ://members.morningstar.com/memberservice/login.aspx?CustId =& CType =& CName =& RememberMe = true& CookieTime = HTTP / 1.1

接受:text / html,application / xhtml + xml,* / *

推荐人:https://members.morningstar.co ... .aspx

**省略**

Cookie:cookies = true; TestCookieExist =存在; fp = 001140581745182496; __utma = 172984700.91600904.1405817457.1405817457.1405817457.1; __utmb = 172984700.8.10.1405817457; __utmz = 172984700.1405817457.1.1.utmcsr =(直接)| utmccn =(直接)| utmcmd =(无); __utmc = 172984700; ASP.NET_SessionId = b5bpepm3pftgoz55to3ql4me

email_textbox=test@email.com& pwd_textbox = password& remember = on& email_textbox2 =& go_button.x = 36& go_button.y = 16& ____ LAST =& __ EVENTARGUMENT =& __ VIEWSTATE =省略& __ EVENTVALIDATION =省略

您将看到一些 cookie 和表单字段,例如“__VIEWSTATE”。需要输入这个文件的实际值才能登录,可以使用以下步骤:

提出请求并删除“__LASTFOCUS”、“__EVENTTARGET”、“__EVENTARGUMENT”、“__VIEWSTATE”、“__EVENTVALIDATION”;

在同一页面上创建一个新的 POST 请求,使用上一个的 CookieContainer;使用废弃的字段、用户名和密码来构造帖子字符串。使用 MIME 类型应用程序/x-www-form-urlencoded 来发布。

如果成功,请使用 cookie 进行进一步请求以保留记录

注意:您可以使用 htmlagilitypack 或 scrapysharp 丢弃 html。ScrapySharp 提供了易于使用的表单发布和浏览工具网站。 查看全部

c httpclient抓取网页(我正在尝试使用C#和ChromeWebInspector登录并在)

问题

我正在尝试使用 C# 和 Chrome Web Inspector 登录并进入。

我不太了解人们必须用来解释 Web Inspector 中的信息以模拟登录和模拟维护会话并导航到下一页以采集信息的心理过程。

有人可以向我解释或指点我吗?

目前,我只有一些代码来获取主页和登录页面的内容:

公共类Morningstar

{

公共异步静态无效Ru4n()

{

var url =" http://www.morningstar.com/";

var httpClient = new HttpClient();

httpClient.DefaultRequestHeaders.TryAddWithoutValidation(" Accept"," text / html,application / xhtml + xml,application / xml");

httpClient.DefaultRequestHeaders.TryAddWithoutValidation(" Accept-Encoding"," gzip,deflate");

httpClient.DefaultRequestHeaders.TryAddWithoutValidation(" User-Agent"," Mozilla / 5.0(Windows NT 6.2; WOW64; rv:19.0)Gecko / 20100101 Firefox / 19.0");

httpClient.DefaultRequestHeaders.TryAddWithoutValidation(" Accept-Charset"," ISO-8859-1");

var response = await httpClient.GetAsync(new Uri(url));

response.EnsureSuccessStatusCode();

使用(var responseStream =等待response.Content.ReadAsStreamAsync())

使用(var decompressedStream = new GZipStream(responseStream,CompressionMode.Decompress))

使用(var streamReader = new StreamReader(decompressedStream) ))

{

//Console.WriteLine(streamReader.ReadToEnd());

}

var loginURL =" https://members.morningstar.co ... 3B%3B

response =等待httpClient.GetAsync(new Uri(loginURL));

response.EnsureSuccessStatusCode();

使用(var responseStream =等待response.Content.ReadAsStreamAsync())

使用(var streamReader = new StreamReader(responseStream))

{

Console.WriteLine(streamReader.ReadToEnd( ));

}

}

编辑:最后,按照穆罕默德的建议,我使用了以下代码:

ScrapingBrowser浏览器= new ScrapingBrowser();

//如果网站返回的cookie格式无效,则将UseDefaultCookiesParser设置为false

//browser.UseDefaultCookiesParser = false;

网页主页=浏览器。NavigateToPage(新Uri(" https://members.morningstar.co ... ot%3B));

PageWebForm form = homePage.FindFormById(" memberLoginForm");

form [" email_textbox"] =" example@example.com";

form [" pwd_textbox"] ="密码";

form [" go_button.x"] =" 57";

form [" go_button.y"] =" 22";

form.Method = HttpVerb.Post;

WebPage resultsPage = form.Submit();

解决方案

你应该模拟网站的登录过程。最简单的方法是通过一些调试器(如 Fiddler)检查 网站。

以下是网站的登录请求:

POST https ://members.morningstar.com/memberservice/login.aspx?CustId =& CType =& CName =& RememberMe = true& CookieTime = HTTP / 1.1

接受:text / html,application / xhtml + xml,* / *

推荐人:https://members.morningstar.co ... .aspx

**省略**

Cookie:cookies = true; TestCookieExist =存在; fp = 001140581745182496; __utma = 172984700.91600904.1405817457.1405817457.1405817457.1; __utmb = 172984700.8.10.1405817457; __utmz = 172984700.1405817457.1.1.utmcsr =(直接)| utmccn =(直接)| utmcmd =(无); __utmc = 172984700; ASP.NET_SessionId = b5bpepm3pftgoz55to3ql4me

email_textbox=test@email.com& pwd_textbox = password& remember = on& email_textbox2 =& go_button.x = 36& go_button.y = 16& ____ LAST =& __ EVENTARGUMENT =& __ VIEWSTATE =省略& __ EVENTVALIDATION =省略

您将看到一些 cookie 和表单字段,例如“__VIEWSTATE”。需要输入这个文件的实际值才能登录,可以使用以下步骤:

提出请求并删除“__LASTFOCUS”、“__EVENTTARGET”、“__EVENTARGUMENT”、“__VIEWSTATE”、“__EVENTVALIDATION”;

在同一页面上创建一个新的 POST 请求,使用上一个的 CookieContainer;使用废弃的字段、用户名和密码来构造帖子字符串。使用 MIME 类型应用程序/x-www-form-urlencoded 来发布。

如果成功,请使用 cookie 进行进一步请求以保留记录

注意:您可以使用 htmlagilitypack 或 scrapysharp 丢弃 html。ScrapySharp 提供了易于使用的表单发布和浏览工具网站。

c httpclient抓取网页(mons.httpclient与org.apache.http.client的区别 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2021-10-23 15:10

)

与传统JDK自带的URLConnection相比,HttpClient增加了易用性和灵活性。不仅方便了客户端发送Http请求,也方便了开发者测试接口(基于Http协议),提高了开发效率,也方便了提高代码的健壮性。因此,掌握HttpClient是非常重要的必修内容。掌握了HttpClient之后,相信你会对Http协议有更深入的了解。

mons.httpclient.HttpClient 和 org.apache.http.client.HttpClient 的区别

Commons HttpClient 项目现已结束,不再开发。它已被 ApacheHttpComponents 项目的 HttpClient 和 HttpCore 模块取代,提供更好的性能和更大的灵活性。

一、简介

HttpClient 是 Apache Jakarta Common 下的一个子项目,用于提供支持 HTTP 协议的高效、最新、功能丰富的客户端编程工具包,它支持 HTTP 协议的最新版本和推荐。HttpClient 已经在很多项目中使用。例如,Apache Jakarta 上的另外两个著名的开源项目 Cactus 和 HTMLUnit,都使用 HttpClient。

所以这里简单介绍一下如何获取网页的源代码:

Maven 依赖:

org.apache.httpcomponents

httpclient

4.5.2

这里最大的问题是编码问题。如果编码不合适,就会出现中文乱码。

获取代码的方式一般有两种,一种是从响应头中获取,另一种是从网页源代码的meta中获取。

这两种方法应该结合使用。一般的过程是先从响应头中获取。如果响应头不可用,请从 Web 源代码元中获取。如果没有,请设置默认编码。

我的代码如下:

<p>package httpclient.download;

import java.io.BufferedReader;

import java.io.ByteArrayOutputStream;

import java.io.IOException;

import java.io.InputStream;

import java.io.StringReader;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

import org.apache.http.HttpEntity;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

/**

* httpclient来下载网页源码。

*

* @author 徐金仁

*

*关于网页下载最大的问题是编码的问题

*

*/

public class Download {

public String getHtmlSource(String url){

String htmlSource = null;

String finallyCharset = null;

//使用httpclient下载

//创建一个httpclient的引擎

CloseableHttpClient httpClient = HttpClients.createDefault();

//创建一个httpGet对象,用于发送get请求,如果要发post请求,就创建一个post对象

HttpGet get = new HttpGet(url);

try {

//发送get请求,获取一个响应

CloseableHttpResponse response= httpClient.execute(get);

//获取这次响应的实体,接下来所有的操作都是基于此实体完成,

HttpEntity entity = response.getEntity();

//方法还是两个,先从header里面来查看,如果没有,再从meta里面查看

//这个方法主要是从header里面来获取,如果没有,会返回一个null

finallyCharset = EntityUtils.getContentCharSet(entity);

System.out.println("编码如下:");

System.out.println("charset1 = " + finallyCharset);

byte[] byteArray = null;

if(finallyCharset == null){

//如果header里面没有,则要从meta里面来获取,为了节约网络资源,网页只读取一次,

/*

* 那么,就有几个关系 :url->字符流->子节流->字符串

* 这里可以用子节数组来作为中间的过渡,从字节数组这里获取到编码,再通过正确的编码变为字符串

*/

byteArray = convertInputStreamToByteArray(entity.getContent());

if(byteArray == null){

throw new Exception("字节数组为空");

}

//接下来要从字节数组中获取到meta里面的chatset

finallyCharset = getCharsetFromMeta(byteArray);

System.out.println("charset2 = " + finallyCharset);

if(finallyCharset == null){

//如果没有找到

finallyCharset = "UTF-8"; //则等于默认的

System.out.println("charset3 = " + finallyCharset);

}

//如果找到了就更好

}

System.out.println("charset = " + finallyCharset);

htmlSource = new String(byteArray, finallyCharset);

}catch (IOException e) {

e.printStackTrace();

} catch (Exception e) {

e.printStackTrace();

}

return htmlSource;

}

/**

* 将一个输入流转化为一个字节数组

* @param content

* @param defaultCharset

* @return

* @throws IOException

*/

public byte[] convertInputStreamToByteArray(InputStream content) throws IOException {

//输入流转化为一个字节数组

byte[] by = new byte[4096];

ByteArrayOutputStream bos = new ByteArrayOutputStream();

int l = -1;

while((l = content.read(by)) > 0){

bos.write(by, 0, l);

}

byte[] s = bos.toByteArray();

return s;

}

/**

* 从字节数组中获取到meta里面的charset的值

* @param byteArray

* @return

* @throws IOException

*/

public String getCharsetFromMeta(byte[] byteArray) throws IOException {

//将字节数组转化为bufferedReader,从中一行行的读取来,再判断

String htmlSource = new String(byteArray);

StringReader in = new StringReader(htmlSource);

BufferedReader reader = new BufferedReader(in);

String line = null;

while((line = reader.readLine()) != null){

line = line.toLowerCase();

if(line.contains(" 查看全部

c httpclient抓取网页(mons.httpclient与org.apache.http.client的区别

)

与传统JDK自带的URLConnection相比,HttpClient增加了易用性和灵活性。不仅方便了客户端发送Http请求,也方便了开发者测试接口(基于Http协议),提高了开发效率,也方便了提高代码的健壮性。因此,掌握HttpClient是非常重要的必修内容。掌握了HttpClient之后,相信你会对Http协议有更深入的了解。

mons.httpclient.HttpClient 和 org.apache.http.client.HttpClient 的区别

Commons HttpClient 项目现已结束,不再开发。它已被 ApacheHttpComponents 项目的 HttpClient 和 HttpCore 模块取代,提供更好的性能和更大的灵活性。

一、简介

HttpClient 是 Apache Jakarta Common 下的一个子项目,用于提供支持 HTTP 协议的高效、最新、功能丰富的客户端编程工具包,它支持 HTTP 协议的最新版本和推荐。HttpClient 已经在很多项目中使用。例如,Apache Jakarta 上的另外两个著名的开源项目 Cactus 和 HTMLUnit,都使用 HttpClient。

所以这里简单介绍一下如何获取网页的源代码:

Maven 依赖:

org.apache.httpcomponents

httpclient

4.5.2

这里最大的问题是编码问题。如果编码不合适,就会出现中文乱码。

获取代码的方式一般有两种,一种是从响应头中获取,另一种是从网页源代码的meta中获取。

这两种方法应该结合使用。一般的过程是先从响应头中获取。如果响应头不可用,请从 Web 源代码元中获取。如果没有,请设置默认编码。

我的代码如下:

<p>package httpclient.download;

import java.io.BufferedReader;

import java.io.ByteArrayOutputStream;

import java.io.IOException;

import java.io.InputStream;

import java.io.StringReader;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

import org.apache.http.HttpEntity;

import org.apache.http.client.methods.CloseableHttpResponse;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.util.EntityUtils;

/**

* httpclient来下载网页源码。

*

* @author 徐金仁

*

*关于网页下载最大的问题是编码的问题

*

*/

public class Download {

public String getHtmlSource(String url){

String htmlSource = null;

String finallyCharset = null;

//使用httpclient下载

//创建一个httpclient的引擎

CloseableHttpClient httpClient = HttpClients.createDefault();

//创建一个httpGet对象,用于发送get请求,如果要发post请求,就创建一个post对象

HttpGet get = new HttpGet(url);

try {

//发送get请求,获取一个响应

CloseableHttpResponse response= httpClient.execute(get);

//获取这次响应的实体,接下来所有的操作都是基于此实体完成,

HttpEntity entity = response.getEntity();

//方法还是两个,先从header里面来查看,如果没有,再从meta里面查看

//这个方法主要是从header里面来获取,如果没有,会返回一个null

finallyCharset = EntityUtils.getContentCharSet(entity);

System.out.println("编码如下:");

System.out.println("charset1 = " + finallyCharset);

byte[] byteArray = null;

if(finallyCharset == null){

//如果header里面没有,则要从meta里面来获取,为了节约网络资源,网页只读取一次,

/*

* 那么,就有几个关系 :url->字符流->子节流->字符串

* 这里可以用子节数组来作为中间的过渡,从字节数组这里获取到编码,再通过正确的编码变为字符串

*/

byteArray = convertInputStreamToByteArray(entity.getContent());

if(byteArray == null){

throw new Exception("字节数组为空");

}

//接下来要从字节数组中获取到meta里面的chatset

finallyCharset = getCharsetFromMeta(byteArray);

System.out.println("charset2 = " + finallyCharset);

if(finallyCharset == null){

//如果没有找到

finallyCharset = "UTF-8"; //则等于默认的

System.out.println("charset3 = " + finallyCharset);

}

//如果找到了就更好

}

System.out.println("charset = " + finallyCharset);

htmlSource = new String(byteArray, finallyCharset);

}catch (IOException e) {

e.printStackTrace();

} catch (Exception e) {

e.printStackTrace();

}

return htmlSource;

}

/**

* 将一个输入流转化为一个字节数组

* @param content

* @param defaultCharset

* @return

* @throws IOException

*/

public byte[] convertInputStreamToByteArray(InputStream content) throws IOException {

//输入流转化为一个字节数组

byte[] by = new byte[4096];

ByteArrayOutputStream bos = new ByteArrayOutputStream();

int l = -1;

while((l = content.read(by)) > 0){

bos.write(by, 0, l);

}

byte[] s = bos.toByteArray();

return s;

}

/**

* 从字节数组中获取到meta里面的charset的值

* @param byteArray

* @return

* @throws IOException

*/

public String getCharsetFromMeta(byte[] byteArray) throws IOException {

//将字节数组转化为bufferedReader,从中一行行的读取来,再判断

String htmlSource = new String(byteArray);

StringReader in = new StringReader(htmlSource);

BufferedReader reader = new BufferedReader(in);

String line = null;

while((line = reader.readLine()) != null){

line = line.toLowerCase();

if(line.contains("

c httpclient抓取网页(一下-Cookie的header信息解析信息的制作 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 83 次浏览 • 2021-10-21 04:02

)

使用HttpClient抓取某些网页时,往往会保留服务器发回的cookie信息,以便发起其他需要这些cookie的请求。在大多数情况下,我们使用内置的 cookie 策略来轻松、直接地获取这些 cookie。

下面一小段代码就是访问和获取对应的cookie:

@Test

public void getCookie(){

CloseableHttpClient httpClient = HttpClients.createDefault();

HttpGet get=new HttpGet("http://www.baidu.com");

HttpClientContext context = HttpClientContext.create();

try {

CloseableHttpResponse response = httpClient.execute(get, context);

try{

System.out.println(">>>>>>headers:");

Arrays.stream(response.getAllHeaders()).forEach(System.out::println);

System.out.println(">>>>>>cookies:");

context.getCookieStore().getCookies().forEach(System.out::println);

}

finally {

response.close();

}

} catch (IOException e) {

e.printStackTrace();

}finally {

try {

httpClient.close();

} catch (IOException e) {

e.printStackTrace();

}

}

}

打印结果

>>>>>>headers:

Server: bfe/1.0.8.18

Date: Tue, 12 Sep 2017 06:19:06 GMT

Content-Type: text/html

Last-Modified: Mon, 23 Jan 2017 13:28:24 GMT

Transfer-Encoding: chunked

Connection: Keep-Alive

Cache-Control: private, no-cache, no-store, proxy-revalidate, no-transform

Pragma: no-cache

Set-Cookie: BDORZ=27315; max-age=86400; domain=.baidu.com; path=/

>>>>>>cookies:

[version: 0][name: BDORZ][value: 27315][domain: baidu.com][path: /][expiry: null]

但是,有一些网站返回的cookies不一定符合规范。比如下面这个例子,从打印的header可以看出,这个cookie中的Expires属性是时间戳的形式,不符合标准时间。因此httpclient处理cookie失败,最终无法获取cookie,并发出警告信息:“Invalid'expires'属性:1505204523”

警告: Invalid cookie header: "Set-Cookie: yd_cookie=90236a64-8650-494b332a285dbd886e5981965fc4a93f023d; Expires=1505204523; Path=/; HttpOnly". Invalid 'expires' attribute: 1505204523

>>>>>>headers:

Date: Tue, 12 Sep 2017 06:22:03 GMT

Content-Type: text/html

Connection: keep-alive

Set-Cookie: yd_cookie=90236a64-8650-494b332a285dbd886e5981965fc4a93f023d; Expires=1505204523; Path=/; HttpOnly

Cache-Control: no-cache, no-store

Server: WAF/2.4-12.1

>>>>>>cookies:

虽然我们可以使用header数据来重构cookie,其实很多人都是这么做的,但是这种方法不够优雅,那么如何解决这个问题呢?网上相关资料很少,只能从官方文档入手。在官方文档3.4节自定义cookie策略中,我们谈到了允许自定义的cookie策略。自定义的方法是实现CookieSpec接口,使用CookieSpecProvider在httpclient中完成策略实例的初始化和注册。好吧,关键线索就在于CookieSpec接口,我们来看看它的源码:

public interface CookieSpec {

……

/**

* Parse the {@code "Set-Cookie"} Header into an array of Cookies.

*

* <p>This method will not perform the validation of the resultant

* {@link Cookie}s

*

* @see #validate

*

* @param header the {@code Set-Cookie} received from the server

* @param origin details of the cookie origin

* @return an array of {@code Cookie}s parsed from the header

* @throws MalformedCookieException if an exception occurs during parsing

*/

List parse(Header header, CookieOrigin origin) throws MalformedCookieException;

……

}</p>

在源码中,我们找到了一个解析方法。看评论,我们知道就是这个方法。Set-Cookie 的头部信息被解析为 Cookie 对象。自然而然,我们就会了解 httplcient 中 DefaultCookieSpec 的默认实现。限于篇幅,源码就不贴出来了。在默认实现中,DefaultCookieSpec 的主要工作是确定头部中 Cookie 规范的类型,然后调用具体的实现。像上面这样的 cookie 最终交给 NetscapeDraftSpec 的实例进行分析。在 NetscapeDraftSpec 的源代码中,默认的过期时间格式定义为“EEE,dd-MMM-yy HH:mm:ss z”

public class NetscapeDraftSpec extends CookieSpecBase {

protected static final String EXPIRES_PATTERN = "EEE, dd-MMM-yy HH:mm:ss z";

/** Default constructor */

public NetscapeDraftSpec(final String[] datepatterns) {

super(new BasicPathHandler(),

new NetscapeDomainHandler(),

new BasicSecureHandler(),

new BasicCommentHandler(),

new BasicExpiresHandler(

datepatterns != null ? datepatterns.clone() : new String[]{EXPIRES_PATTERN}));

}

NetscapeDraftSpec(final CommonCookieAttributeHandler... handlers) {

super(handlers);

}

public NetscapeDraftSpec() {

this((String[]) null);

}

……

}

至此,就清楚了,我们只需要将Cookie中的expires time转换成正确的格式,然后发送给默认的解析器即可。

解决方案:

自定义一个 CookieSpec 类,继承 DefaultCookieSpec,重写解析器方法,将 Cookie 中的 expires 转换成正确的时间格式,调用默认的解析方法

实现如下(网址不公开,已隐藏)

public class TestHttpClient {

String url = sth;

class MyCookieSpec extends DefaultCookieSpec {

@Override

public List parse(Header header, CookieOrigin cookieOrigin) throws MalformedCookieException {

String value = header.getValue();

String prefix = "Expires=";

if (value.contains(prefix)) {

String expires = value.substring(value.indexOf(prefix) + prefix.length());

expires = expires.substring(0, expires.indexOf(";"));

String date = DateUtils.formatDate(new Date(Long.parseLong(expires) * 1000L),"EEE, dd-MMM-yy HH:mm:ss z");

value = value.replaceAll(prefix + "\\d{10};", prefix + date + ";");

}

header = new BasicHeader(header.getName(), value);

return super.parse(header, cookieOrigin);

}

}

@Test

public void getCookie() {

CloseableHttpClient httpClient = HttpClients.createDefault();

Registry cookieSpecProviderRegistry = RegistryBuilder.create()

.register("myCookieSpec", context -> new MyCookieSpec()).build();//注册自定义CookieSpec

HttpClientContext context = HttpClientContext.create();

context.setCookieSpecRegistry(cookieSpecProviderRegistry);

HttpGet get = new HttpGet(url);

get.setConfig(RequestConfig.custom().setCookieSpec("myCookieSpec").build());

try {

CloseableHttpResponse response = httpClient.execute(get, context);

try{

System.out.println(">>>>>>headers:");

Arrays.stream(response.getAllHeaders()).forEach(System.out::println);

System.out.println(">>>>>>cookies:");

context.getCookieStore().getCookies().forEach(System.out::println);

}

finally {

response.close();

}

} catch (IOException e) {

e.printStackTrace();

}finally {

try {

httpClient.close();

} catch (IOException e) {

e.printStackTrace();

}

}

}

}

再次运行,顺利打印出正确的结果,完美!

>>>>>>headers:

Date: Tue, 12 Sep 2017 07:24:10 GMT

Content-Type: text/html

Connection: keep-alive

Set-Cookie: yd_cookie=9f521fc5-0248-4ab3ee650ca50b1c7abb1cd2526b830e620f; Expires=1505208250; Path=/; HttpOnly

Cache-Control: no-cache, no-store

Server: WAF/2.4-12.1

>>>>>>cookies:

[version: 0][name: yd_cookie][value: 9f521fc5-0248-4ab3ee650ca50b1c7abb1cd2526b830e620f][domain: www.sth.com][path: /][expiry: Tue Sep 12 17:24:10 CST 2017] 查看全部

c httpclient抓取网页(一下-Cookie的header信息解析信息的制作

)

使用HttpClient抓取某些网页时,往往会保留服务器发回的cookie信息,以便发起其他需要这些cookie的请求。在大多数情况下,我们使用内置的 cookie 策略来轻松、直接地获取这些 cookie。

下面一小段代码就是访问和获取对应的cookie:

@Test

public void getCookie(){

CloseableHttpClient httpClient = HttpClients.createDefault();

HttpGet get=new HttpGet("http://www.baidu.com";);

HttpClientContext context = HttpClientContext.create();

try {

CloseableHttpResponse response = httpClient.execute(get, context);

try{

System.out.println(">>>>>>headers:");

Arrays.stream(response.getAllHeaders()).forEach(System.out::println);

System.out.println(">>>>>>cookies:");

context.getCookieStore().getCookies().forEach(System.out::println);

}

finally {

response.close();

}

} catch (IOException e) {

e.printStackTrace();

}finally {

try {

httpClient.close();

} catch (IOException e) {

e.printStackTrace();

}

}

}

打印结果

>>>>>>headers:

Server: bfe/1.0.8.18

Date: Tue, 12 Sep 2017 06:19:06 GMT

Content-Type: text/html

Last-Modified: Mon, 23 Jan 2017 13:28:24 GMT

Transfer-Encoding: chunked

Connection: Keep-Alive

Cache-Control: private, no-cache, no-store, proxy-revalidate, no-transform

Pragma: no-cache

Set-Cookie: BDORZ=27315; max-age=86400; domain=.baidu.com; path=/

>>>>>>cookies:

[version: 0][name: BDORZ][value: 27315][domain: baidu.com][path: /][expiry: null]

但是,有一些网站返回的cookies不一定符合规范。比如下面这个例子,从打印的header可以看出,这个cookie中的Expires属性是时间戳的形式,不符合标准时间。因此httpclient处理cookie失败,最终无法获取cookie,并发出警告信息:“Invalid'expires'属性:1505204523”

警告: Invalid cookie header: "Set-Cookie: yd_cookie=90236a64-8650-494b332a285dbd886e5981965fc4a93f023d; Expires=1505204523; Path=/; HttpOnly". Invalid 'expires' attribute: 1505204523

>>>>>>headers:

Date: Tue, 12 Sep 2017 06:22:03 GMT

Content-Type: text/html

Connection: keep-alive

Set-Cookie: yd_cookie=90236a64-8650-494b332a285dbd886e5981965fc4a93f023d; Expires=1505204523; Path=/; HttpOnly

Cache-Control: no-cache, no-store

Server: WAF/2.4-12.1

>>>>>>cookies:

虽然我们可以使用header数据来重构cookie,其实很多人都是这么做的,但是这种方法不够优雅,那么如何解决这个问题呢?网上相关资料很少,只能从官方文档入手。在官方文档3.4节自定义cookie策略中,我们谈到了允许自定义的cookie策略。自定义的方法是实现CookieSpec接口,使用CookieSpecProvider在httpclient中完成策略实例的初始化和注册。好吧,关键线索就在于CookieSpec接口,我们来看看它的源码:

public interface CookieSpec {

……

/**

* Parse the {@code "Set-Cookie"} Header into an array of Cookies.

*

* <p>This method will not perform the validation of the resultant

* {@link Cookie}s

*

* @see #validate

*

* @param header the {@code Set-Cookie} received from the server

* @param origin details of the cookie origin

* @return an array of {@code Cookie}s parsed from the header

* @throws MalformedCookieException if an exception occurs during parsing

*/

List parse(Header header, CookieOrigin origin) throws MalformedCookieException;

……

}</p>

在源码中,我们找到了一个解析方法。看评论,我们知道就是这个方法。Set-Cookie 的头部信息被解析为 Cookie 对象。自然而然,我们就会了解 httplcient 中 DefaultCookieSpec 的默认实现。限于篇幅,源码就不贴出来了。在默认实现中,DefaultCookieSpec 的主要工作是确定头部中 Cookie 规范的类型,然后调用具体的实现。像上面这样的 cookie 最终交给 NetscapeDraftSpec 的实例进行分析。在 NetscapeDraftSpec 的源代码中,默认的过期时间格式定义为“EEE,dd-MMM-yy HH:mm:ss z”

public class NetscapeDraftSpec extends CookieSpecBase {

protected static final String EXPIRES_PATTERN = "EEE, dd-MMM-yy HH:mm:ss z";

/** Default constructor */

public NetscapeDraftSpec(final String[] datepatterns) {

super(new BasicPathHandler(),

new NetscapeDomainHandler(),

new BasicSecureHandler(),

new BasicCommentHandler(),

new BasicExpiresHandler(

datepatterns != null ? datepatterns.clone() : new String[]{EXPIRES_PATTERN}));

}

NetscapeDraftSpec(final CommonCookieAttributeHandler... handlers) {

super(handlers);

}

public NetscapeDraftSpec() {

this((String[]) null);

}

……

}

至此,就清楚了,我们只需要将Cookie中的expires time转换成正确的格式,然后发送给默认的解析器即可。

解决方案:

自定义一个 CookieSpec 类,继承 DefaultCookieSpec,重写解析器方法,将 Cookie 中的 expires 转换成正确的时间格式,调用默认的解析方法

实现如下(网址不公开,已隐藏)

public class TestHttpClient {

String url = sth;

class MyCookieSpec extends DefaultCookieSpec {

@Override

public List parse(Header header, CookieOrigin cookieOrigin) throws MalformedCookieException {

String value = header.getValue();

String prefix = "Expires=";

if (value.contains(prefix)) {

String expires = value.substring(value.indexOf(prefix) + prefix.length());

expires = expires.substring(0, expires.indexOf(";"));

String date = DateUtils.formatDate(new Date(Long.parseLong(expires) * 1000L),"EEE, dd-MMM-yy HH:mm:ss z");

value = value.replaceAll(prefix + "\\d{10};", prefix + date + ";");

}

header = new BasicHeader(header.getName(), value);

return super.parse(header, cookieOrigin);

}

}

@Test

public void getCookie() {

CloseableHttpClient httpClient = HttpClients.createDefault();

Registry cookieSpecProviderRegistry = RegistryBuilder.create()

.register("myCookieSpec", context -> new MyCookieSpec()).build();//注册自定义CookieSpec

HttpClientContext context = HttpClientContext.create();

context.setCookieSpecRegistry(cookieSpecProviderRegistry);

HttpGet get = new HttpGet(url);

get.setConfig(RequestConfig.custom().setCookieSpec("myCookieSpec").build());

try {

CloseableHttpResponse response = httpClient.execute(get, context);

try{

System.out.println(">>>>>>headers:");

Arrays.stream(response.getAllHeaders()).forEach(System.out::println);

System.out.println(">>>>>>cookies:");

context.getCookieStore().getCookies().forEach(System.out::println);

}

finally {

response.close();

}

} catch (IOException e) {

e.printStackTrace();

}finally {

try {

httpClient.close();

} catch (IOException e) {

e.printStackTrace();

}

}

}

}

再次运行,顺利打印出正确的结果,完美!

>>>>>>headers:

Date: Tue, 12 Sep 2017 07:24:10 GMT

Content-Type: text/html

Connection: keep-alive

Set-Cookie: yd_cookie=9f521fc5-0248-4ab3ee650ca50b1c7abb1cd2526b830e620f; Expires=1505208250; Path=/; HttpOnly

Cache-Control: no-cache, no-store

Server: WAF/2.4-12.1

>>>>>>cookies:

[version: 0][name: yd_cookie][value: 9f521fc5-0248-4ab3ee650ca50b1c7abb1cd2526b830e620f][domain: www.sth.com][path: /][expiry: Tue Sep 12 17:24:10 CST 2017]

c httpclient抓取网页(() )

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-10-20 15:07

)

1、GET 方法

第一步是创建一个客户端,类似于用浏览器打开一个网页

HttpClient httpClient = new HttpClient();

第二步是创建一个GET方法来获取你需要爬取的网页的网址

GetMethod getMethod = new GetMethod("");

第三步,获取URL的响应状态码,200表示请求成功

int statusCode = httpClient.executeMethod(getMethod);

第四步,获取网页源代码

byte[] responseBody = getMethod.getResponseBody();

主要就是这四个步骤,当然还有很多其他的,比如网页编码的问题

1 public static String spiderHtml() throws Exception {

2 //URL url = new URL("http://top.baidu.com/buzz?b=1");

3

4 HttpClient client = new HttpClient();

5 GetMethod method = new GetMethod("http://top.baidu.com/buzz?b=1");

6

7 int statusCode = client.executeMethod(method);

8 if(statusCode != HttpStatus.SC_OK) {

9 System.err.println("Method failed: " + method.getStatusLine());

10 }

11

12 byte[] body = method.getResponseBody();

13 String html = new String(body,"gbk");

<br /><br />2、Post方式<br /><br /><br /><br /><br />1 HttpClient httpClient = new HttpClient();

2 PostMethod postMethod = new PostMethod(UrlPath);

3 postMethod.getParams().setParameter(HttpMethodParams.RETRY_HANDLER,new DefaultHttpMethodRetryHandler());

4 NameValuePair[] postData = new NameValuePair[2];

5 postData[0] = new NameValuePair("username", "xkey");

6 postData[1] = new NameValuePair("userpass", "********");

7 postMethod.setRequestBody(postData);

8 try {

9 int statusCode = httpClient.executeMethod(postMethod);

10 if (statusCode == HttpStatus.SC_OK) {

11 byte[] responseBody = postMethod.getResponseBody();

12 String html = new String(responseBody);

13 System.out.println(html);

14 }

15 } catch (Exception e) { <br />16 System.err.println("页面无法访问");

17 }finally{

18 postMethod.releaseConnection();

19 } <br /><br /><br /><br /><br /><br /><br />相关链接:http://blog.csdn.net/acceptedx ... %3Bbr />

http://www.cnblogs.com/modou/articles/1325569.html

查看全部

c httpclient抓取网页(()

)

1、GET 方法

第一步是创建一个客户端,类似于用浏览器打开一个网页

HttpClient httpClient = new HttpClient();

第二步是创建一个GET方法来获取你需要爬取的网页的网址

GetMethod getMethod = new GetMethod("");

第三步,获取URL的响应状态码,200表示请求成功

int statusCode = httpClient.executeMethod(getMethod);

第四步,获取网页源代码

byte[] responseBody = getMethod.getResponseBody();

主要就是这四个步骤,当然还有很多其他的,比如网页编码的问题

1 public static String spiderHtml() throws Exception {

2 //URL url = new URL("http://top.baidu.com/buzz?b=1";);

3

4 HttpClient client = new HttpClient();

5 GetMethod method = new GetMethod("http://top.baidu.com/buzz?b=1";);

6

7 int statusCode = client.executeMethod(method);

8 if(statusCode != HttpStatus.SC_OK) {

9 System.err.println("Method failed: " + method.getStatusLine());

10 }

11

12 byte[] body = method.getResponseBody();

13 String html = new String(body,"gbk");

<br /><br />2、Post方式<br /><br /><br /><br /><br />1 HttpClient httpClient = new HttpClient();

2 PostMethod postMethod = new PostMethod(UrlPath);

3 postMethod.getParams().setParameter(HttpMethodParams.RETRY_HANDLER,new DefaultHttpMethodRetryHandler());

4 NameValuePair[] postData = new NameValuePair[2];

5 postData[0] = new NameValuePair("username", "xkey");

6 postData[1] = new NameValuePair("userpass", "********");

7 postMethod.setRequestBody(postData);

8 try {

9 int statusCode = httpClient.executeMethod(postMethod);

10 if (statusCode == HttpStatus.SC_OK) {

11 byte[] responseBody = postMethod.getResponseBody();

12 String html = new String(responseBody);

13 System.out.println(html);

14 }

15 } catch (Exception e) { <br />16 System.err.println("页面无法访问");

17 }finally{

18 postMethod.releaseConnection();

19 } <br /><br /><br /><br /><br /><br /><br />相关链接:http://blog.csdn.net/acceptedx ... %3Bbr />

http://www.cnblogs.com/modou/articles/1325569.html

c httpclient抓取网页(() )

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-10-20 15:04

)

1、GET 方法

第一步是创建一个客户端,类似于用浏览器打开一个网页

HttpClient httpClient = new HttpClient();

第二步是创建一个GET方法来获取你需要爬取的网页的网址

GetMethod getMethod = new GetMethod("");

第三步,获取URL的响应状态码,200表示请求成功

int statusCode = httpClient.executeMethod(getMethod);

第四步,获取网页源代码

byte[] responseBody = getMethod.getResponseBody();

主要就是这四个步骤,当然还有很多其他的,比如网页编码的问题

1 public static String spiderHtml() throws Exception {

2 //URL url = new URL("http://top.baidu.com/buzz?b=1");

3

4 HttpClient client = new HttpClient();

5 GetMethod method = new GetMethod("http://top.baidu.com/buzz?b=1");

6

7 int statusCode = client.executeMethod(method);

8 if(statusCode != HttpStatus.SC_OK) {

9 System.err.println("Method failed: " + method.getStatusLine());

10 }

11

12 byte[] body = method.getResponseBody();

13 String html = new String(body,"gbk");

2、Post方式

1 HttpClient httpClient = new HttpClient();

2 PostMethod postMethod = new PostMethod(UrlPath);

3 postMethod.getParams().setParameter(HttpMethodParams.RETRY_HANDLER,new DefaultHttpMethodRetryHandler());

4 NameValuePair[] postData = new NameValuePair[2];

5 postData[0] = new NameValuePair("username", "xkey");

6 postData[1] = new NameValuePair("userpass", "********");

7 postMethod.setRequestBody(postData);

8 try {

9 int statusCode = httpClient.executeMethod(postMethod);

10 if (statusCode == HttpStatus.SC_OK) {

11 byte[] responseBody = postMethod.getResponseBody();

12 String html = new String(responseBody);

13 System.out.println(html);

14 }

15 } catch (Exception e) {

16 System.err.println("页面无法访问");

17 }finally{

18 postMethod.releaseConnection();

19 }

相关链接:http://blog.csdn.net/acceptedx ... 30700

http://www.cnblogs.com/modou/articles/1325569.html

查看全部

c httpclient抓取网页(()

)

1、GET 方法

第一步是创建一个客户端,类似于用浏览器打开一个网页

HttpClient httpClient = new HttpClient();

第二步是创建一个GET方法来获取你需要爬取的网页的网址

GetMethod getMethod = new GetMethod("");

第三步,获取URL的响应状态码,200表示请求成功

int statusCode = httpClient.executeMethod(getMethod);

第四步,获取网页源代码

byte[] responseBody = getMethod.getResponseBody();

主要就是这四个步骤,当然还有很多其他的,比如网页编码的问题

1 public static String spiderHtml() throws Exception {

2 //URL url = new URL("http://top.baidu.com/buzz?b=1";);

3

4 HttpClient client = new HttpClient();

5 GetMethod method = new GetMethod("http://top.baidu.com/buzz?b=1";);

6

7 int statusCode = client.executeMethod(method);

8 if(statusCode != HttpStatus.SC_OK) {

9 System.err.println("Method failed: " + method.getStatusLine());

10 }

11

12 byte[] body = method.getResponseBody();

13 String html = new String(body,"gbk");

2、Post方式

1 HttpClient httpClient = new HttpClient();

2 PostMethod postMethod = new PostMethod(UrlPath);

3 postMethod.getParams().setParameter(HttpMethodParams.RETRY_HANDLER,new DefaultHttpMethodRetryHandler());

4 NameValuePair[] postData = new NameValuePair[2];

5 postData[0] = new NameValuePair("username", "xkey");

6 postData[1] = new NameValuePair("userpass", "********");

7 postMethod.setRequestBody(postData);

8 try {

9 int statusCode = httpClient.executeMethod(postMethod);

10 if (statusCode == HttpStatus.SC_OK) {

11 byte[] responseBody = postMethod.getResponseBody();

12 String html = new String(responseBody);

13 System.out.println(html);

14 }

15 } catch (Exception e) {

16 System.err.println("页面无法访问");

17 }finally{

18 postMethod.releaseConnection();

19 }

相关链接:http://blog.csdn.net/acceptedx ... 30700

http://www.cnblogs.com/modou/articles/1325569.html

c httpclient抓取网页(一下和网页采集相关的组件和插件有什么区别?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2021-10-19 06:04

其实很多做Java编程的人都不懂SEO,不知道怎么去百度收录等。当然,不是所有程序员都考虑爬网和网页爬虫,但是他们是专门针对这个人的. ,还是需要了解一下里面的知识,接下来介绍一些爬虫和网页采集相关的组件和插件~

大家在做爬虫、网页采集、通过网页自动写数据的时候基本都接触过这两个组件。网上已经有很多介绍资料了。我想从实际应用开始,从一个角度谈谈我对这两个组件的看法,并将它们记录在博客中,以便我以后阅读。欢迎大家批评指正。

本文主要比较两者的优缺点并介绍应用中的使用技巧,推荐一些入门资料和非常实用的辅助工具,希望对大家有所帮助。

如果您有任何问题或建议,您可以给我留言,共同交流和学习。

我们先来看看这两个组件的区别和优缺点:

单位

HtmlUnit 最初是一个自动化测试工具。它结合使用HttpClient和java自带的网络api来实现。它和HttpClient的区别在于它比HttpClient更“人性化”。

写HtmlUnit代码的时候,好像是在操作浏览器而不是写代码获取页面(getPage)-找到文本框(getElementByID || getElementByName || getElementByXPath等)-输入文本(type, setValue, setText,等)——其他一些类似的操作——找到提交按钮——提交——得到一个新的Page,这样就很像后台有人帮你操作浏览器了,你只要告诉他怎么操作要操作,需要填写哪些值。

一、网页模拟

首先,让我谈谈 HtmlUnit 相对于 HttpClient 最明显的好处之一。HtmlUnit 更好地将网页封装成一个对象。如果非要说HttpClient返回的接口HttpResponse其实存储的是一个对象,那很好,但是HtmlUnit不仅保存了网页对象,更难能可贵的是它还存储了网页的所有基本操作甚至事件. 也就是说,我们可以像在jsp中写js一样操作这个网页,非常方便,比如:你要一个节点的上一个节点,找到所有的按钮,找到“bt-style”的样式为所有元素,先修改一些元素,再转成String,或者我直接拿到这个网页然后操作这个网页,很方便的完成一个提交。这意味着如果你想分析一个网页,那将是非常容易的。比如我附上一段百度新闻高级搜索的代码:

// 得到浏览器对象,直接New一个就能得到,现在就好比说你得到了一个浏览器了

WebClient webclient = new WebClient();

// 这里是配置一下不加载css和javaScript,配置起来很简单,是不是

webclient.getOptions().setCssEnabled(false);

webclient.getOptions().setJavaScriptEnabled(false);

// 做的第一件事,去拿到这个网页,只需要调用getPage这个方法即可

HtmlPage htmlpage = webclient.getPage("http://news.baidu.com/advanced_news.html");

// 根据名字得到一个表单,查看上面这个网页的源代码可以发现表单的名字叫"f”

final HtmlForm form = htmlpage.getFormByName("f");

// 同样道理,获取”百度一下“这个按钮

final HtmlSubmitInput button = form.getInputByValue("百度一下");

// 得到搜索框

final HtmlTextInput textField = form.getInputByName("q1");

// 最近周星驰比较火呀,我这里设置一下在搜索框内填入"周星驰"

textField.setValueAttribute("周星驰");

// 输入好了,我们点一下这个按钮

final HtmlPage nextPage = button.click();

// 我把结果转成String

String result = nextPage.asXml();

System.out.println(result);

然后就可以将结果结果复制到一个文本中,然后用浏览器打开该文本。是你想要的吗(见图)?这很简单,对吧?为什么感觉简单,因为完全符合我们的操作和浏览,当然最后也是通过HttpClient等一些工具类来实现的,但是封装的非常人性化,很神奇。

Htmlunit可以有效的分析dom标签,可以有效的在页面上运行js,得到一些需要执行js的值。您需要做的就是执行 executeJavaScript() 方法。这些都是HtmlUnit为我们封装的。好吧,我们所要做的就是告诉它需要做什么。

WebClient webclient = new WebClient();

HtmlPage htmlpage = webclient.getPage("you url");

htmlpage.executeJavaScript("the function name you want to execute");

对于使用Java的程序员来说,对象的操作再熟悉不过了,HtmlUnit所做的就是帮助我们把网页封装成一个对象,一个功能丰富的透明对象。

二、自动处理网络响应

HtmlUnit有强大的响应处理机制,我们知道:常见的404是资源未找到,100是继续,300是跳转……当我们使用HttpClient时,它会告诉我们响应结果,当然你可以做自己判断,比如当你发现响应码是302时,会在响应头中找到新地址,自动跳过。当您发现它是 100 时,您将发送另一个请求。如果你使用HttpClient,你可以做这个来做,也可以写的更完整,但是HtmlUnit把这个功能实现的更完整,甚至说还包括页面JS的自动跳转(响应码是200,但是响应页面是一个JS),天涯的登录就是这样的情况,一起来看看吧。

/**

* @author CaiBo

* @date 2014年9月15日 上午9:16:36

* @version $Id$

*

*/

public class TianyaTest {

public static void main(String[] args) throws Exception {

// 这是一个测试,也是为了让大家看的更清楚,请暂时抛开代码规范性,不要纠结于我多建了一个局部变量等

// 得到认证https的浏览器对象

HttpClient client = getSSLInsecureClient();

// 得到我们需要的post流

HttpPost post = getPost();

// 使用我们的浏览器去执行这个流,得到我们的结果

HttpResponse hr = client.execute(post);

// 在控制台输出我们想要的一些信息

showResponseInfo(hr);

}

private static void showResponseInfo(HttpResponse hr) throws ParseException, IOException {

System.out.println("响应状态行信息:" + hr.getStatusLine());

System.out.println("—————————————————————");

System.out.println("响应头信息:");

Header[] allHeaders = hr.getAllHeaders();

for (int i = 0; i < allHeaders.length; i++) {

System.out.println(allHeaders[i].getName() + ":" + allHeaders[i].getValue());

}

System.out.println("—————————————————————");

System.out.println("响应正文:");

System.out.println(EntityUtils.toString(hr.getEntity()));

}

// 得到一个认证https链接的HttpClient对象(因为我们将要的天涯登录是Https的)

// 具体是如何工作的我们后面会提到的

private static HttpClient getSSLInsecureClient() throws Exception {

// 建立一个认证上下文,认可所有安全链接,当然,这是因为我们仅仅是测试,实际中认可所有安全链接是危险的

SSLContext sslContext = new SSLContextBuilder().loadTrustMaterial(null,

new TrustStrategy() {

public boolean isTrusted(X509Certificate[] chain, String authType) throws CertificateException {

return true;

}

}).build();

SSLConnectionSocketFactory sslsf = new SSLConnectionSocketFactory(sslContext);

return HttpClients.custom().setSSLSocketFactory(sslsf)//

// .setProxy(new HttpHost("127.0.0.1", 8888))

.build();

}

// 获取我们需要的Post流,如果你是把我的代码复制过去,请记得更改为你的用户名和密码

private static HttpPost getPost() {

HttpPost post = new HttpPost("https://passport.tianya.cn/login");

// 首先我们初始化请求头

post.addHeader("Referer", "https://passport.tianya.cn/login.jsp");

post.addHeader("Host", "passport.tianya.cn");

post.addHeader("Origin", "http://passport.tianya.cn");

// 然后我们填入我们想要传递的表单参数(主要也就是传递我们的用户名和密码)

// 我们可以先建立一个List,之后通过post.setEntity方法传入即可

// 写在一起主要是为了大家看起来方便,大家在正式使用的当然是要分开处理,优化代码结构的

List paramsList = new ArrayList();

/*

* 添加我们要的参数,这些可以通过查看浏览器中的网络看到,如下面我的截图中看到的一样

* 不论你用的是firebut,httpWatch或者是谷歌自带的查看器也好,都能查看到(后面会推荐辅助工具来查看)

* 要把表单需要的参数都填齐,顺序不影响

*/

paramsList.add(new BasicNameValuePair("Submit", ""));

paramsList.add(new BasicNameValuePair("fowardURL", "http://www.tianya.cn"));

paramsList.add(new BasicNameValuePair("from", ""));

paramsList.add(new BasicNameValuePair("method", "name"));

paramsList.add(new BasicNameValuePair("returnURL", ""));

paramsList.add(new BasicNameValuePair("rmflag", "1"));

paramsList.add(new BasicNameValuePair("__sid", "1#1#1.0#a6c606d9-1efa-4e12-8ad5-3eefd12b8254"));

// 你可以申请一个天涯的账号 并在下两行代码中替换为你的用户名和密码

paramsList.add(new BasicNameValuePair("vwriter", "ifugletest2014"));// 替换为你的用户名

paramsList.add(new BasicNameValuePair("vpassword", "test123456"));// 你的密码

// 将这个参数list设置到post中

post.setEntity(new UrlEncodedFormEntity(paramsList, Consts.UTF_8));

return post;

}

}

执行上面的Main函数会得到如下结果:

我们看到响应码确实是200,表示成功。其实这个响应相当于302,需要跳转,只不过它的跳转写在js的body部分。

location.href=”http://passport.tianya.cn:80/o ... %25AD……&t=1410746182629&k=8cd4d967491c44c5eab1097e0f30c054&c=6fc7ebf8d782a07bb06624d9c6fbbf3f”;

这是页面跳转 查看全部

c httpclient抓取网页(一下和网页采集相关的组件和插件有什么区别?)

其实很多做Java编程的人都不懂SEO,不知道怎么去百度收录等。当然,不是所有程序员都考虑爬网和网页爬虫,但是他们是专门针对这个人的. ,还是需要了解一下里面的知识,接下来介绍一些爬虫和网页采集相关的组件和插件~

大家在做爬虫、网页采集、通过网页自动写数据的时候基本都接触过这两个组件。网上已经有很多介绍资料了。我想从实际应用开始,从一个角度谈谈我对这两个组件的看法,并将它们记录在博客中,以便我以后阅读。欢迎大家批评指正。

本文主要比较两者的优缺点并介绍应用中的使用技巧,推荐一些入门资料和非常实用的辅助工具,希望对大家有所帮助。

如果您有任何问题或建议,您可以给我留言,共同交流和学习。

我们先来看看这两个组件的区别和优缺点:

单位

HtmlUnit 最初是一个自动化测试工具。它结合使用HttpClient和java自带的网络api来实现。它和HttpClient的区别在于它比HttpClient更“人性化”。

写HtmlUnit代码的时候,好像是在操作浏览器而不是写代码获取页面(getPage)-找到文本框(getElementByID || getElementByName || getElementByXPath等)-输入文本(type, setValue, setText,等)——其他一些类似的操作——找到提交按钮——提交——得到一个新的Page,这样就很像后台有人帮你操作浏览器了,你只要告诉他怎么操作要操作,需要填写哪些值。

一、网页模拟

首先,让我谈谈 HtmlUnit 相对于 HttpClient 最明显的好处之一。HtmlUnit 更好地将网页封装成一个对象。如果非要说HttpClient返回的接口HttpResponse其实存储的是一个对象,那很好,但是HtmlUnit不仅保存了网页对象,更难能可贵的是它还存储了网页的所有基本操作甚至事件. 也就是说,我们可以像在jsp中写js一样操作这个网页,非常方便,比如:你要一个节点的上一个节点,找到所有的按钮,找到“bt-style”的样式为所有元素,先修改一些元素,再转成String,或者我直接拿到这个网页然后操作这个网页,很方便的完成一个提交。这意味着如果你想分析一个网页,那将是非常容易的。比如我附上一段百度新闻高级搜索的代码:

// 得到浏览器对象,直接New一个就能得到,现在就好比说你得到了一个浏览器了

WebClient webclient = new WebClient();

// 这里是配置一下不加载css和javaScript,配置起来很简单,是不是

webclient.getOptions().setCssEnabled(false);

webclient.getOptions().setJavaScriptEnabled(false);

// 做的第一件事,去拿到这个网页,只需要调用getPage这个方法即可

HtmlPage htmlpage = webclient.getPage("http://news.baidu.com/advanced_news.html";);

// 根据名字得到一个表单,查看上面这个网页的源代码可以发现表单的名字叫"f”

final HtmlForm form = htmlpage.getFormByName("f");

// 同样道理,获取”百度一下“这个按钮

final HtmlSubmitInput button = form.getInputByValue("百度一下");

// 得到搜索框

final HtmlTextInput textField = form.getInputByName("q1");

// 最近周星驰比较火呀,我这里设置一下在搜索框内填入"周星驰"

textField.setValueAttribute("周星驰");

// 输入好了,我们点一下这个按钮

final HtmlPage nextPage = button.click();

// 我把结果转成String

String result = nextPage.asXml();

System.out.println(result);

然后就可以将结果结果复制到一个文本中,然后用浏览器打开该文本。是你想要的吗(见图)?这很简单,对吧?为什么感觉简单,因为完全符合我们的操作和浏览,当然最后也是通过HttpClient等一些工具类来实现的,但是封装的非常人性化,很神奇。

Htmlunit可以有效的分析dom标签,可以有效的在页面上运行js,得到一些需要执行js的值。您需要做的就是执行 executeJavaScript() 方法。这些都是HtmlUnit为我们封装的。好吧,我们所要做的就是告诉它需要做什么。

WebClient webclient = new WebClient();

HtmlPage htmlpage = webclient.getPage("you url");

htmlpage.executeJavaScript("the function name you want to execute");

对于使用Java的程序员来说,对象的操作再熟悉不过了,HtmlUnit所做的就是帮助我们把网页封装成一个对象,一个功能丰富的透明对象。

二、自动处理网络响应

HtmlUnit有强大的响应处理机制,我们知道:常见的404是资源未找到,100是继续,300是跳转……当我们使用HttpClient时,它会告诉我们响应结果,当然你可以做自己判断,比如当你发现响应码是302时,会在响应头中找到新地址,自动跳过。当您发现它是 100 时,您将发送另一个请求。如果你使用HttpClient,你可以做这个来做,也可以写的更完整,但是HtmlUnit把这个功能实现的更完整,甚至说还包括页面JS的自动跳转(响应码是200,但是响应页面是一个JS),天涯的登录就是这样的情况,一起来看看吧。

/**

* @author CaiBo

* @date 2014年9月15日 上午9:16:36

* @version $Id$

*

*/

public class TianyaTest {

public static void main(String[] args) throws Exception {

// 这是一个测试,也是为了让大家看的更清楚,请暂时抛开代码规范性,不要纠结于我多建了一个局部变量等

// 得到认证https的浏览器对象

HttpClient client = getSSLInsecureClient();

// 得到我们需要的post流

HttpPost post = getPost();

// 使用我们的浏览器去执行这个流,得到我们的结果

HttpResponse hr = client.execute(post);

// 在控制台输出我们想要的一些信息

showResponseInfo(hr);

}

private static void showResponseInfo(HttpResponse hr) throws ParseException, IOException {

System.out.println("响应状态行信息:" + hr.getStatusLine());

System.out.println("—————————————————————");

System.out.println("响应头信息:");

Header[] allHeaders = hr.getAllHeaders();

for (int i = 0; i < allHeaders.length; i++) {

System.out.println(allHeaders[i].getName() + ":" + allHeaders[i].getValue());

}

System.out.println("—————————————————————");

System.out.println("响应正文:");

System.out.println(EntityUtils.toString(hr.getEntity()));

}

// 得到一个认证https链接的HttpClient对象(因为我们将要的天涯登录是Https的)

// 具体是如何工作的我们后面会提到的

private static HttpClient getSSLInsecureClient() throws Exception {

// 建立一个认证上下文,认可所有安全链接,当然,这是因为我们仅仅是测试,实际中认可所有安全链接是危险的

SSLContext sslContext = new SSLContextBuilder().loadTrustMaterial(null,

new TrustStrategy() {

public boolean isTrusted(X509Certificate[] chain, String authType) throws CertificateException {

return true;

}

}).build();