asp.net 抓取网页数据

asp.net 抓取网页数据(抓取网页数据大概有以下4种方法:netframesetview.4)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-03-25 17:04

抓取网页数据大概有以下4种方法:

1、netframesetview(简称nf)framesetview支持java和.netcore两种协议网络抓取模块。安装方法很简单,直接在support中找到netframesetview()。

2、nfasnfa是netframesetview()的升级版本,提供了可自定义的“原生”网络获取方法。安装方法也很简单,

3、netframesetestgamescriptingconfiguration(简称ngsoc)与networkingsettings()相比,ngsoc的确是有更多的好处,但两者确实没有可比性。因为ngsoc更像是一个“辅助工具”,功能不再是原生网络抓取模块那么全面和强大。安装方法也很简单,在support中找到ngsoc()。

4、urlresourceresourceresource是一个统一资源收集器。通过这个工具,一旦设置完这些页面,其他java、.netcore或其他方法也可以访问这些“原生”网络数据。安装方法非常简单,

不同意@余天昊的答案,我已经用.netcore2.4测试过,2.4是支持加速原生3.0之前版本的浏览器(浏览器端执行;无论是jsp、php、cgi、asp、webgl、lua、jquery.等等)的,包括注入你自己想要的那一部分网页。具体操作如下:启动vscode->edit>preferences>advanced>urlresource>javanativeresourcenew->preferences>advanced>javanativescript->第一个resource就是我要用的。我用的是下面这个。 查看全部

asp.net 抓取网页数据(抓取网页数据大概有以下4种方法:netframesetview.4)

抓取网页数据大概有以下4种方法:

1、netframesetview(简称nf)framesetview支持java和.netcore两种协议网络抓取模块。安装方法很简单,直接在support中找到netframesetview()。

2、nfasnfa是netframesetview()的升级版本,提供了可自定义的“原生”网络获取方法。安装方法也很简单,

3、netframesetestgamescriptingconfiguration(简称ngsoc)与networkingsettings()相比,ngsoc的确是有更多的好处,但两者确实没有可比性。因为ngsoc更像是一个“辅助工具”,功能不再是原生网络抓取模块那么全面和强大。安装方法也很简单,在support中找到ngsoc()。

4、urlresourceresourceresource是一个统一资源收集器。通过这个工具,一旦设置完这些页面,其他java、.netcore或其他方法也可以访问这些“原生”网络数据。安装方法非常简单,

不同意@余天昊的答案,我已经用.netcore2.4测试过,2.4是支持加速原生3.0之前版本的浏览器(浏览器端执行;无论是jsp、php、cgi、asp、webgl、lua、jquery.等等)的,包括注入你自己想要的那一部分网页。具体操作如下:启动vscode->edit>preferences>advanced>urlresource>javanativeresourcenew->preferences>advanced>javanativescript->第一个resource就是我要用的。我用的是下面这个。

asp.net 抓取网页数据(什么是Sitemap?Sitemap.Net可方便管理员通知(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-03-21 02:05

)

首先我要说明一下:Asp.Net内置的Sitemap和这里说的Sitemap是完全不一样的。Asp.Net中的Sitemap主要是用来导航用户的,这里所说的Sitemap是用来引导搜索引擎爬虫的。

我们来看看官方的解释:

什么是站点地图?

站点地图允许管理员通知搜索引擎他们 网站 可以抓取哪些页面。在最简单的形式中,Sitepmap 是一个 XML 文件,其中列出了 网站 中的 URL 和有关每个 URL 的其他元数据(上次更新时间、更改频率以及相对于 网站 其他 URL 的重要性等),以便搜索引擎可以更智能地抓取 网站。

网络爬虫通常通过 网站 和其他 网站 中的链接来查找网页。站点地图提供此数据以允许启用站点地图的爬虫抓取站点地图提供的所有 URL,并了解哪些 URL 使用相关元数据。使用 Sitemap 协议并不能保证页面会被搜索引擎收录,但它会为网络爬虫提供一些提示,以便它们可以更有效地爬取 网站。

站点地图 0.90 是根据 Attribution-ShareAlike Creative Commons License 条款提供的,并被包括 Google、Yahoo! 在内的许多供应商广泛使用和支持。和微软。

引:

综上所述,提供Sitemap是一种辅助搜索引擎爬虫收录网站的手段。没有Sitemap,你的网站就是收录,但是有了Sitemap,收录会更全面、更准确。

除了提供网址,最重要的是提供页面的更新时间戳,以及网站关注和更新回访频率建议,让搜索引擎更准确的掌握你的网站@ >。

如何实现Sitemap的自动生成?

有很多开箱即用的生成器:

但是,在 Asp.Net 中,并没有官方的生成工具。搜索“Asp.Net Sitemap”也发现了很多Asp.Net内置的Sitemap功能介绍页面。

因此,我希望自己实现一个Asp.Net Sitemap 生成工具。并且希望这个工具能够与Asp.Net同步交互更新数据,保证数据的及时性;而大多数其他生成器就像一个私人爬虫,你需要手动释放它来爬取你的 网站 来为整个站点生成站点地图,我不喜欢。

Xml站点地图

这是我实现的站点地图生成工具。简单说一下实现方法:

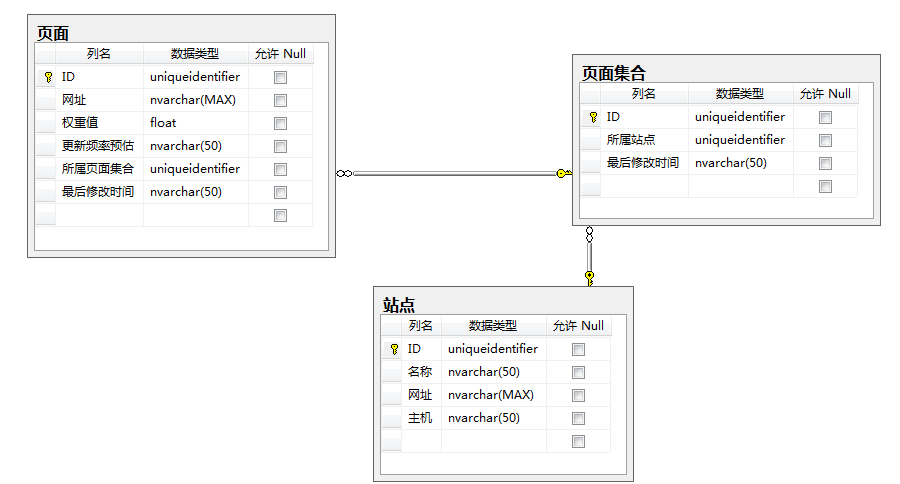

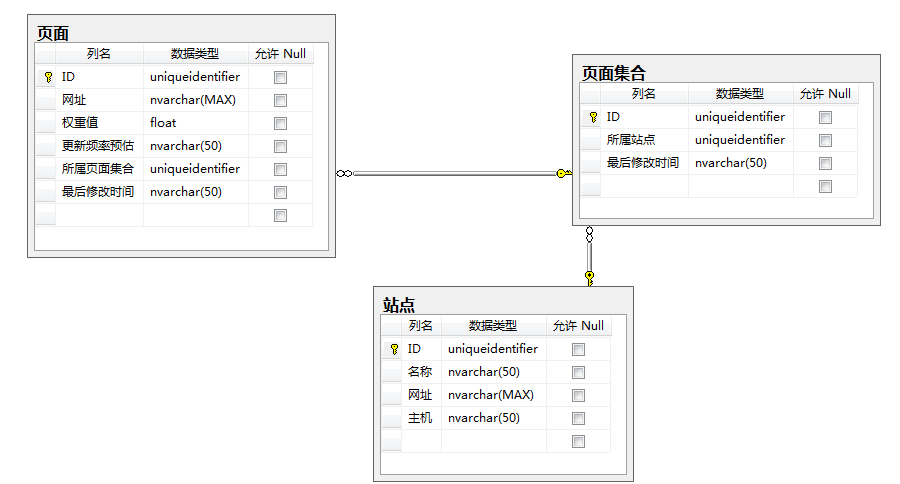

通过数据库存储站点、页面集合、页面数据:

请点击进入图片说明

在 Asp.Net网站 中,在添加、删除或修改数据时,调用站点地图公开的方法来更新数据库数据。

XML 格式的 Sitemap 通过 Ashx 输出,供搜索引擎爬虫读取。

在文章的最后我会分享这个项目的下载链接,然后我会谈谈如何使用这个项目。

如何部署?

我将提供以下文件用于在现有 Asp.Net网站 中部署此功能:

请点击进入图片说明

首先参考 XmlSitemap.dll。

然后通过“添加现有项”将 XMLSiteMap.ashx.cs 和 XMLSiteMap.ashx 添加到项目中。

然后通过“添加现有项”将 SiteMap.mdf 添加到项目的 App_Data 目录中。

在 Web.Config 中指定 SiteMap.mdf 的数据库连接字符串:

在项目中添加一个新的 Global.asax 文件(如果之前没有创建过这个文件)并在它的 Application_Start 中初始化它:

请点击进入图片说明

蓝色高亮部分是上面Web.Config中指定的SiteMap.mdf的数据库连接字符串;

黄色高亮部分是你的网站名字,每次提交数据都会用到;

绿色突出显示的部分是您网站的 URL,每个新的 URL 数据必须位于该 URL 的域名下。

如何使用?

我们将模拟使用按钮添加数据:

protectedvoidButton1_Click(objectsender, EventArgse)

{

varid=Guid.NewGuid();

Sitemap.Add Page("MySite", id,Path.Combine("","Page.aspx?ID="+id),0.5,Update Frequency.Daily);

}

注意:这里只是为了测试,所以临时生成了一个Guid传入sitemap,但在实际使用中,应该和你原来数据入口的Guid一起传入,因为你以后可能会更新,删除操作,如果你想同时在站点地图中体现出来,你还必须使用它的Guid作为标识符来找到它。

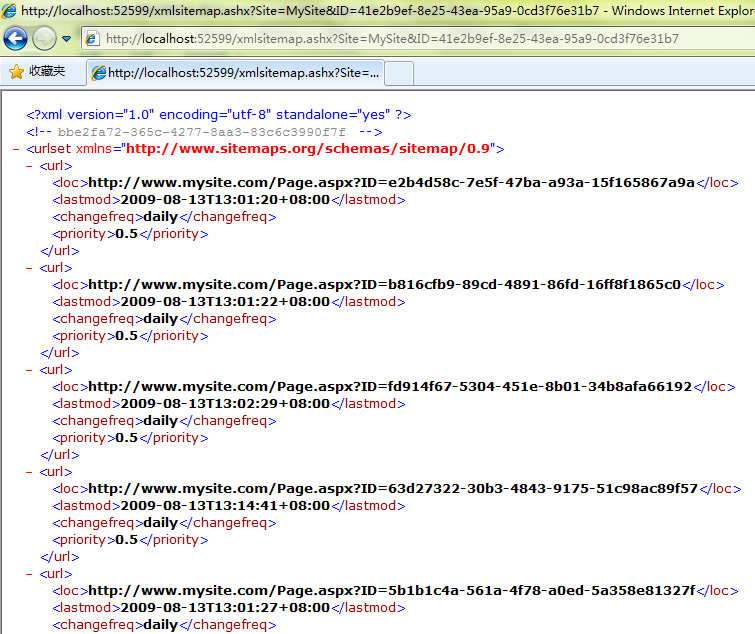

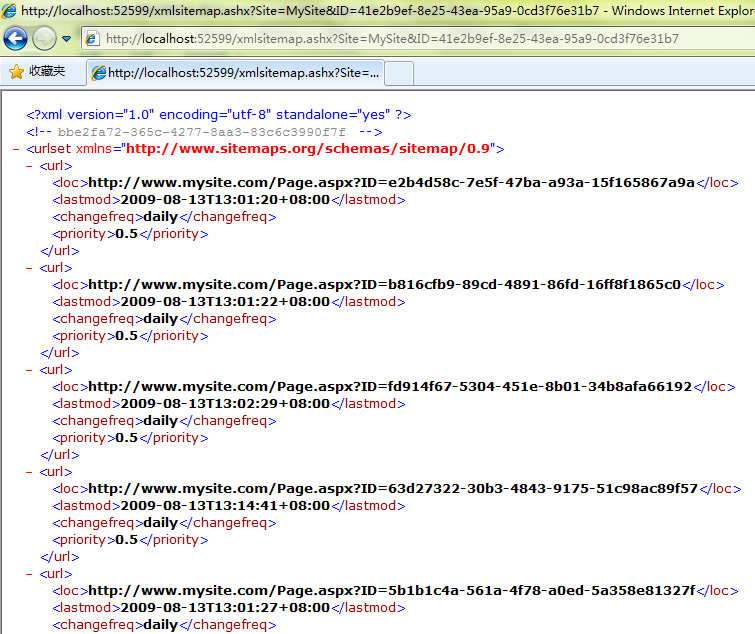

当您经常单击此按钮时,会在站点地图中添加多条数据。您可以通过访问 XmlSiteMap.ashx?Site=MySite 查看当前页面采集列表:

请点击进入图片说明

Url 地址是页面集合的 URL。由于页面数据量没有达到页面集合的上限,所以目前只有一个页面集合。

访问页面集合的 URL:

请点击进入图片说明

这里是每个页面的详细地址和相关信息列表。

除了添加数据,还有更新、删除等方法。由于都是中文写的,很容易理解,这里就不一一演示了:

查看全部

asp.net 抓取网页数据(什么是Sitemap?Sitemap.Net可方便管理员通知(组图)

)

首先我要说明一下:Asp.Net内置的Sitemap和这里说的Sitemap是完全不一样的。Asp.Net中的Sitemap主要是用来导航用户的,这里所说的Sitemap是用来引导搜索引擎爬虫的。

我们来看看官方的解释:

什么是站点地图?

站点地图允许管理员通知搜索引擎他们 网站 可以抓取哪些页面。在最简单的形式中,Sitepmap 是一个 XML 文件,其中列出了 网站 中的 URL 和有关每个 URL 的其他元数据(上次更新时间、更改频率以及相对于 网站 其他 URL 的重要性等),以便搜索引擎可以更智能地抓取 网站。

网络爬虫通常通过 网站 和其他 网站 中的链接来查找网页。站点地图提供此数据以允许启用站点地图的爬虫抓取站点地图提供的所有 URL,并了解哪些 URL 使用相关元数据。使用 Sitemap 协议并不能保证页面会被搜索引擎收录,但它会为网络爬虫提供一些提示,以便它们可以更有效地爬取 网站。

站点地图 0.90 是根据 Attribution-ShareAlike Creative Commons License 条款提供的,并被包括 Google、Yahoo! 在内的许多供应商广泛使用和支持。和微软。

引:

综上所述,提供Sitemap是一种辅助搜索引擎爬虫收录网站的手段。没有Sitemap,你的网站就是收录,但是有了Sitemap,收录会更全面、更准确。

除了提供网址,最重要的是提供页面的更新时间戳,以及网站关注和更新回访频率建议,让搜索引擎更准确的掌握你的网站@ >。

如何实现Sitemap的自动生成?

有很多开箱即用的生成器:

但是,在 Asp.Net 中,并没有官方的生成工具。搜索“Asp.Net Sitemap”也发现了很多Asp.Net内置的Sitemap功能介绍页面。

因此,我希望自己实现一个Asp.Net Sitemap 生成工具。并且希望这个工具能够与Asp.Net同步交互更新数据,保证数据的及时性;而大多数其他生成器就像一个私人爬虫,你需要手动释放它来爬取你的 网站 来为整个站点生成站点地图,我不喜欢。

Xml站点地图

这是我实现的站点地图生成工具。简单说一下实现方法:

通过数据库存储站点、页面集合、页面数据:

请点击进入图片说明

在 Asp.Net网站 中,在添加、删除或修改数据时,调用站点地图公开的方法来更新数据库数据。

XML 格式的 Sitemap 通过 Ashx 输出,供搜索引擎爬虫读取。

在文章的最后我会分享这个项目的下载链接,然后我会谈谈如何使用这个项目。

如何部署?

我将提供以下文件用于在现有 Asp.Net网站 中部署此功能:

请点击进入图片说明

首先参考 XmlSitemap.dll。

然后通过“添加现有项”将 XMLSiteMap.ashx.cs 和 XMLSiteMap.ashx 添加到项目中。

然后通过“添加现有项”将 SiteMap.mdf 添加到项目的 App_Data 目录中。

在 Web.Config 中指定 SiteMap.mdf 的数据库连接字符串:

在项目中添加一个新的 Global.asax 文件(如果之前没有创建过这个文件)并在它的 Application_Start 中初始化它:

请点击进入图片说明

蓝色高亮部分是上面Web.Config中指定的SiteMap.mdf的数据库连接字符串;

黄色高亮部分是你的网站名字,每次提交数据都会用到;

绿色突出显示的部分是您网站的 URL,每个新的 URL 数据必须位于该 URL 的域名下。

如何使用?

我们将模拟使用按钮添加数据:

protectedvoidButton1_Click(objectsender, EventArgse)

{

varid=Guid.NewGuid();

Sitemap.Add Page("MySite", id,Path.Combine("","Page.aspx?ID="+id),0.5,Update Frequency.Daily);

}

注意:这里只是为了测试,所以临时生成了一个Guid传入sitemap,但在实际使用中,应该和你原来数据入口的Guid一起传入,因为你以后可能会更新,删除操作,如果你想同时在站点地图中体现出来,你还必须使用它的Guid作为标识符来找到它。

当您经常单击此按钮时,会在站点地图中添加多条数据。您可以通过访问 XmlSiteMap.ashx?Site=MySite 查看当前页面采集列表:

请点击进入图片说明

Url 地址是页面集合的 URL。由于页面数据量没有达到页面集合的上限,所以目前只有一个页面集合。

访问页面集合的 URL:

请点击进入图片说明

这里是每个页面的详细地址和相关信息列表。

除了添加数据,还有更新、删除等方法。由于都是中文写的,很容易理解,这里就不一一演示了:

asp.net 抓取网页数据(本文就用Java给大家演示怎样抓取站点的数据:(1))

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-03-17 19:22

有时出于各种原因,我们需要从某个站点采集数据,但是因为不同站点显示数据的方式略有不同!

本文使用Java为大家展示如何抓取网站的数据:(1)抓取原创网页数据;(2)抓取网页Javascript返回的数据。

一、获取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页,然后输入IP:111.142.55.73,点击查询按钮,可以看到网页上显示的结果:

第二步:查看网页的源码,我们看到源码中有这么一段:

由此可以看出,再次请求网页后,才显示查询结果。

看看查询后的网页地址:

也就是说,我们只有通过访问这样的URL才能得到ip查询的结果。接下来看代码:

public void captureHtml(String ip) throws Exception {<br /> String strURL = "http://ip.chinaz.com/?IP=" + ip;<br /> URL url = new URL(strURL);<br /> HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();<br /> InputStreamReader input = new InputStreamReader(httpConn<br /> .getInputStream(), "utf-8");<br /> BufferedReader bufReader = new BufferedReader(input);<br /> String line = "";<br /> StringBuilder contentBuf = new StringBuilder();<br /> while ((line = bufReader.readLine()) != null) {<br /> contentBuf.append(line);<br /> }<br /> String buf = contentBuf.toString();<br /> int beginIx = buf.indexOf("查询结果[");<br /> int endIx = buf.indexOf("上面四项依次显示的是");<br /> String result = buf.substring(beginIx, endIx);<br /> System.out.println("captureHtml()的结果:\n" + result);<br />}

使用HttpURLConnection连接网站,使用bufReader保存网页返回的数据,然后通过自定义解析方式显示结果。

这里我只是随便解析了一下。如果解析非常准确,需要我自己处理。

解析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建漳州移动

二、在网页上获取 JavaScript 返回的结果。

有时网站为了保护自己的数据,不会直接在网页源码中返回数据,而是使用JS异步返回数据,这样可以避免工具抓取网站数据比如搜索引擎。

先看看这个页面:

第一种方式查看网页源代码,但是没有找到运单的跟踪信息,因为它是通过JS的方式获取结果的。

但是有时候我们非常需要获取JS数据,这个时候我们应该怎么做呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以截取Http的交互内容,我们利用这个工具来达到我们的目的。

先点击开始按钮后,开始监听网页的交互行为。 查看全部

asp.net 抓取网页数据(本文就用Java给大家演示怎样抓取站点的数据:(1))

有时出于各种原因,我们需要从某个站点采集数据,但是因为不同站点显示数据的方式略有不同!

本文使用Java为大家展示如何抓取网站的数据:(1)抓取原创网页数据;(2)抓取网页Javascript返回的数据。

一、获取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页,然后输入IP:111.142.55.73,点击查询按钮,可以看到网页上显示的结果:

第二步:查看网页的源码,我们看到源码中有这么一段:

由此可以看出,再次请求网页后,才显示查询结果。

看看查询后的网页地址:

也就是说,我们只有通过访问这样的URL才能得到ip查询的结果。接下来看代码:

public void captureHtml(String ip) throws Exception {<br /> String strURL = "http://ip.chinaz.com/?IP=" + ip;<br /> URL url = new URL(strURL);<br /> HttpURLConnection httpConn = (HttpURLConnection) url.openConnection();<br /> InputStreamReader input = new InputStreamReader(httpConn<br /> .getInputStream(), "utf-8");<br /> BufferedReader bufReader = new BufferedReader(input);<br /> String line = "";<br /> StringBuilder contentBuf = new StringBuilder();<br /> while ((line = bufReader.readLine()) != null) {<br /> contentBuf.append(line);<br /> }<br /> String buf = contentBuf.toString();<br /> int beginIx = buf.indexOf("查询结果[");<br /> int endIx = buf.indexOf("上面四项依次显示的是");<br /> String result = buf.substring(beginIx, endIx);<br /> System.out.println("captureHtml()的结果:\n" + result);<br />}

使用HttpURLConnection连接网站,使用bufReader保存网页返回的数据,然后通过自定义解析方式显示结果。

这里我只是随便解析了一下。如果解析非常准确,需要我自己处理。

解析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建漳州移动

二、在网页上获取 JavaScript 返回的结果。

有时网站为了保护自己的数据,不会直接在网页源码中返回数据,而是使用JS异步返回数据,这样可以避免工具抓取网站数据比如搜索引擎。

先看看这个页面:

第一种方式查看网页源代码,但是没有找到运单的跟踪信息,因为它是通过JS的方式获取结果的。

但是有时候我们非常需要获取JS数据,这个时候我们应该怎么做呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以截取Http的交互内容,我们利用这个工具来达到我们的目的。

先点击开始按钮后,开始监听网页的交互行为。

asp.net 抓取网页数据(ASP.NET中抓取网页内容-防止重定向在网页时保持登录状态 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-03-14 19:13

)

在 ASP.NET 中爬取网页内容非常方便,解决了 ASP 中困扰我们的编码问题。

1、获取一般内容

需要三个类:WebRequest、WebResponse、StreamReader

需要命名空间:System.Net、System.IO

核心代码:

WebRequest类的create是一个静态方法,参数是要爬取的网页的URL;

Encoding指定编码,Encoding有属性ASCII、UTF32、UTF8等通用编码,但没有编码属性gb2312,所以我们使用GetEncoding获取gb2312编码。

private string GetGeneralContent(string strUrl)

{

string strMsg = string.Empty;

try

{

WebRequest request = WebRequest.Create(strUrl);

WebResponse response = request.GetResponse();

StreamReader reader = new StreamReader(response.GetResponseStream(), Encoding.GetEncoding("gb2312"));

strMsg = reader.ReadToEnd();

reader.Close();

reader.Dispose();

response.Close();

}

catch

{ }

return strMsg;

}

2、 抓取图片或其他二进制文件(如文件) 需要四个类:WebRequest、WebResponse、Stream、FileStream 需要命名空间:System.Net、System.IO 核心代码:用Stream读取

private string GetFileContent(string strUrl)

{

string strMsg = string.Empty;

try

{

WebRequest request = WebRequest.Create(strUrl);

WebResponse response = request.GetResponse();

Stream reader = response.GetResponseStream();

//可根据实际保存为具体文件

FileStream writer = new FileStream("D:\\logo.gif", FileMode.OpenOrCreate, FileAccess.Write);

byte[] buff = new byte[512];

int c = 0; //实际读取的字节数

while ((c=reader.Read(buff, 0, buff.Length)) > 0)

{

writer.Write(buff, 0, c);

}

writer.Close();

writer.Dispose();

reader.Close();

reader.Dispose();

response.Close();

strMsg = "保存成功";

}

catch

{ }

return strMsg;

}

3、抓取网页内容POST方式在抓取网页时,有时需要通过Post方式将一些数据发送到服务器,在网页抓取程序中加入如下代码实现Post用户名密码到服务器:

private string GetPostContent(string strUrl)

{

string strMsg = string.Empty;

try

{

string data = "userName=admin&passwd=admin888";

byte[] requestBuffer = System.Text.Encoding.GetEncoding("gb2312").GetBytes(data);

WebRequest request = WebRequest.Create(strUrl);

request.Method = "POST";

request.ContentType = "application/x-www-form-urlencoded";

request.ContentLength = requestBuffer.Length;

using (Stream requestStream = request.GetRequestStream())

{

requestStream.Write(requestBuffer, 0, requestBuffer.Length);

requestStream.Close();

}

WebResponse response = request.GetResponse();

using (StreamReader reader = new StreamReader(response.GetResponseStream(), Encoding.GetEncoding("gb2312")))

{

strMsg = reader.ReadToEnd();

reader.Close();

}

}

catch

{ }

return strMsg;

}

4、ASP.NET爬取网页内容——防止重定向 爬取网页时,成功登录服务器应用系统后,应用系统可以通过Response.Redirect重定向网页,如果不需要响应这个重定向,那么,我们不需要将 reader.ReadToEnd() 发送到 Response.Write,就是这样。 5、ASP.NET爬取网页内容——维护登录状态使用Post数据成功登录服务器应用系统后,我们可以爬取需要登录的页面,那么我们可能需要维护登录状态多个请求之间的状态。首先,我们将使用 HttpWebRequest,而不是 WebRequest。相比WebRequest,修改后的代码是:

HttpWebRequest request = (HttpWebRequest)HttpWebRequest.Create(strUrl);

注意:HttpWebRequest.Create返回的类型还是WebRequest,所以需要进行转换。二、使用CookieContainer。

System.Net.CookieContainer cc = new System.Net.CookieContainer();

request.CookieContainer = cc;

request2.CookieContainer = cc;

这样,request和request2之间使用的是同一个Session。如果 request 已登录,则 request2 也已登录。

最后,如何在不同页面之间使用同一个CookieContainer。

要在不同页面之间使用相同的CookieContainer,只需将CookieContainer添加到Session中即可。

Session.Add("ccc", cc); //存

CookieContainer cc = (CookieContainer)Session["ccc"]; //取Session

6、ASP.NET 抓取网页内容 - 将当前会话带到 WebRequest

例如,浏览器B1访问服务器S1,会产生会话,服务器S2使用WebRequest访问服务器S1,会产生会话。现在的要求是让WebRequest使用浏览器B1和S1之间的会话,也就是说让S1认为B1在访问S1,而不是S2访问S1。

这是为了使用cookies。首先在S1中获取SessionID为B1的cookie,然后将cookie告诉S2,S2会在WebRequest中写入cookie。

WebRequest request = WebRequest.Create("url");

request.Headers.Add(HttpRequestHeader.Cookie, "ASPSESSIONIDSCATBTAD=KNNDKCNBONBOOBIHHHHAOKDM;");

WebResponse response = request.GetResponse();

StreamReader reader = new StreamReader(response.GetResponseStream(), System.Text.Encoding.GetEncoding("gb2312"));

Response.Write(reader.ReadToEnd());

reader.Close();

reader.Dispose();

response.Close();

据说:

本文不是cookiespoofing,因为SessionID是S1告诉S2的,不是S2偷的,虽然有点奇怪,但在某些特定的应用系统中可能有用。

S1 必须将 Session 写入 B1,这样 SessionID 才会保存到 cookie 中,SessionID 保持不变。

在 ASP.NET 中使用 Request.Cookies 获取 cookie。本文假设 cookie 已被取出。

服务器端语言不同,cookie中的SessionID名称不一样,本文为ASP的SessionID。

S1可能不仅仅依靠SessionID判断当前登录,还可能辅助Referer、User-Agent等,这取决于S1端程序的设计。

其实这篇文章是本系列“保持登录”的另一种方式。

7、ASP.NET Crawl Web Content - 如何更改 Source Referer 和 UserAgent

HttpWebRequest request = (HttpWebRequest)HttpWebRequest.Create("http://127.0.0.1/index.htm");

request.Referer = "http://www.csdn.net/";

request.UserAgent = "要设置的标头";

//下一步的处理 查看全部

asp.net 抓取网页数据(ASP.NET中抓取网页内容-防止重定向在网页时保持登录状态

)

在 ASP.NET 中爬取网页内容非常方便,解决了 ASP 中困扰我们的编码问题。

1、获取一般内容

需要三个类:WebRequest、WebResponse、StreamReader

需要命名空间:System.Net、System.IO

核心代码:

WebRequest类的create是一个静态方法,参数是要爬取的网页的URL;

Encoding指定编码,Encoding有属性ASCII、UTF32、UTF8等通用编码,但没有编码属性gb2312,所以我们使用GetEncoding获取gb2312编码。

private string GetGeneralContent(string strUrl)

{

string strMsg = string.Empty;

try

{

WebRequest request = WebRequest.Create(strUrl);

WebResponse response = request.GetResponse();

StreamReader reader = new StreamReader(response.GetResponseStream(), Encoding.GetEncoding("gb2312"));

strMsg = reader.ReadToEnd();

reader.Close();

reader.Dispose();

response.Close();

}

catch

{ }

return strMsg;

}

2、 抓取图片或其他二进制文件(如文件) 需要四个类:WebRequest、WebResponse、Stream、FileStream 需要命名空间:System.Net、System.IO 核心代码:用Stream读取

private string GetFileContent(string strUrl)

{

string strMsg = string.Empty;

try

{

WebRequest request = WebRequest.Create(strUrl);

WebResponse response = request.GetResponse();

Stream reader = response.GetResponseStream();

//可根据实际保存为具体文件

FileStream writer = new FileStream("D:\\logo.gif", FileMode.OpenOrCreate, FileAccess.Write);

byte[] buff = new byte[512];

int c = 0; //实际读取的字节数

while ((c=reader.Read(buff, 0, buff.Length)) > 0)

{

writer.Write(buff, 0, c);

}

writer.Close();

writer.Dispose();

reader.Close();

reader.Dispose();

response.Close();

strMsg = "保存成功";

}

catch

{ }

return strMsg;

}

3、抓取网页内容POST方式在抓取网页时,有时需要通过Post方式将一些数据发送到服务器,在网页抓取程序中加入如下代码实现Post用户名密码到服务器:

private string GetPostContent(string strUrl)

{

string strMsg = string.Empty;

try

{

string data = "userName=admin&passwd=admin888";

byte[] requestBuffer = System.Text.Encoding.GetEncoding("gb2312").GetBytes(data);

WebRequest request = WebRequest.Create(strUrl);

request.Method = "POST";

request.ContentType = "application/x-www-form-urlencoded";

request.ContentLength = requestBuffer.Length;

using (Stream requestStream = request.GetRequestStream())

{

requestStream.Write(requestBuffer, 0, requestBuffer.Length);

requestStream.Close();

}

WebResponse response = request.GetResponse();

using (StreamReader reader = new StreamReader(response.GetResponseStream(), Encoding.GetEncoding("gb2312")))

{

strMsg = reader.ReadToEnd();

reader.Close();

}

}

catch

{ }

return strMsg;

}

4、ASP.NET爬取网页内容——防止重定向 爬取网页时,成功登录服务器应用系统后,应用系统可以通过Response.Redirect重定向网页,如果不需要响应这个重定向,那么,我们不需要将 reader.ReadToEnd() 发送到 Response.Write,就是这样。 5、ASP.NET爬取网页内容——维护登录状态使用Post数据成功登录服务器应用系统后,我们可以爬取需要登录的页面,那么我们可能需要维护登录状态多个请求之间的状态。首先,我们将使用 HttpWebRequest,而不是 WebRequest。相比WebRequest,修改后的代码是:

HttpWebRequest request = (HttpWebRequest)HttpWebRequest.Create(strUrl);

注意:HttpWebRequest.Create返回的类型还是WebRequest,所以需要进行转换。二、使用CookieContainer。

System.Net.CookieContainer cc = new System.Net.CookieContainer();

request.CookieContainer = cc;

request2.CookieContainer = cc;

这样,request和request2之间使用的是同一个Session。如果 request 已登录,则 request2 也已登录。

最后,如何在不同页面之间使用同一个CookieContainer。

要在不同页面之间使用相同的CookieContainer,只需将CookieContainer添加到Session中即可。

Session.Add("ccc", cc); //存

CookieContainer cc = (CookieContainer)Session["ccc"]; //取Session

6、ASP.NET 抓取网页内容 - 将当前会话带到 WebRequest

例如,浏览器B1访问服务器S1,会产生会话,服务器S2使用WebRequest访问服务器S1,会产生会话。现在的要求是让WebRequest使用浏览器B1和S1之间的会话,也就是说让S1认为B1在访问S1,而不是S2访问S1。

这是为了使用cookies。首先在S1中获取SessionID为B1的cookie,然后将cookie告诉S2,S2会在WebRequest中写入cookie。

WebRequest request = WebRequest.Create("url");

request.Headers.Add(HttpRequestHeader.Cookie, "ASPSESSIONIDSCATBTAD=KNNDKCNBONBOOBIHHHHAOKDM;");

WebResponse response = request.GetResponse();

StreamReader reader = new StreamReader(response.GetResponseStream(), System.Text.Encoding.GetEncoding("gb2312"));

Response.Write(reader.ReadToEnd());

reader.Close();

reader.Dispose();

response.Close();

据说:

本文不是cookiespoofing,因为SessionID是S1告诉S2的,不是S2偷的,虽然有点奇怪,但在某些特定的应用系统中可能有用。

S1 必须将 Session 写入 B1,这样 SessionID 才会保存到 cookie 中,SessionID 保持不变。

在 ASP.NET 中使用 Request.Cookies 获取 cookie。本文假设 cookie 已被取出。

服务器端语言不同,cookie中的SessionID名称不一样,本文为ASP的SessionID。

S1可能不仅仅依靠SessionID判断当前登录,还可能辅助Referer、User-Agent等,这取决于S1端程序的设计。

其实这篇文章是本系列“保持登录”的另一种方式。

7、ASP.NET Crawl Web Content - 如何更改 Source Referer 和 UserAgent

HttpWebRequest request = (HttpWebRequest)HttpWebRequest.Create("http://127.0.0.1/index.htm";);

request.Referer = "http://www.csdn.net/";

request.UserAgent = "要设置的标头";

//下一步的处理

asp.net 抓取网页数据(ASP.NET2.0中新增的SqlCacheDependency特性使这成为了可能)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2022-03-13 14:09

ASP.NET中的Page Cache是一个非常有用的东西,只要简单的在页面顶部添加一个OutputCache标签,就可以让页面在指定的Duration内直接输出自动保存在缓存中的页面内容,无需需要让 ASP.NET 引擎再次执行页面代码。当然,节省执行时间并不是主要原因。主要原因是如果页面内容是从数据库中取出来的,那么连接数据库和取数据的步骤就可以省略。这带来的好处是巨大的。

PageCache 有一个小问题。比如很多ASP.NET论坛的首页使用PageCache,所以一个版本发布的最新帖子不会立即反映在首页,需要等待一段时间。虽然有点不情愿,但在某些情况下(例如 eBay 用来显示物品拍卖状态的页面),这种延迟是不允许的。

也就是说,ASP.NET中的Cache不能根据数据库中对应的数据自动改变,对应的Cache就过期了。ASP.NET 2.0 中的新 SqlCacheDependency 功能使这成为可能。. (当然,只要了解了ASP.NET2.0中的一般实现,就可以基于ASP.NET1.0实现这个特性,后面会总结对应的方法。)

要在 ASP.NET 2.0 中应用 SqlCacheDependency 功能,步骤如下(基于您手头的 Whidbey PDC 版本):

1、 使数据库支持SqlCacheDependency

在.Net Framework1.2(一般是WINDOWS/Microsoft.NET/Framework/v1.2.30703)的安装目录下,有一个aspnet_regsqlcache.exe,这个命令行工具允许我们的 SqlServer 7.0 或 SqlServer 2000 支持 SqlCacheDependency 特性,

首先:“aspnet_regsqlcache -S 服务器名 -U 登录ID -P 密码 -d 数据库名 -ed”,该命令使指定数据库支持SqlCacheDependency,

然后我们添加要跟踪的数据表:“aspnet_regsqlcache -S 服务器名 -U 登录ID -P 密码 -d 数据库名 -t 要跟踪的数据表名 -et”,该命令启用指定表支持SqlCache 依赖关系。

它在幕后做什么?

首先,它在指定的数据库中创建一个新表,名为

“AspNet_SqlCacheTablesForChangeNotification”,这个表有3个字段,“tableName”记录要跟踪的数据表的名称,“notificationCreated”记录开始跟踪的时间,“changeId”是一个int类型的字段,每当跟踪数据的数据表发生变化时,该字段的值加1。它还在指定的数据库中添加了几个存储过程,以允许ASP.NET引擎查询被跟踪数据表的状态。然后,它会在我们要跟踪的Table中添加几个Trigger,分别对应Insert、Update和Delete操作。这些Triggers的语句很简单,就是“AspNet_SqlCacheTablesForChangeNotification”中对应的“tableName”字段

默认情况下,这个存储过程每 500 毫秒执行一次,但是这个间隔可以在 web.config 中修改。我的经验是,这个查询操作也是非常耗费资源的,呵呵。2、 web.config 配置 web.config 中的配置再简单不过了3、 在页面的 outputCache 标签中指定 SqlCacheDependency 属性: 只要在这个tracked上执行Insert、Update、Delete表操作,数据表上的Trigger会修改数据库中“AspNet_SqlCacheTablesForChangeNotification”表中对应记录对应的“changId”字段值,然后ASP.NET引擎获取新值就知道跟踪表已更改。,这会自动使该页面的缓存无效。下一个故事1、育空地区呢?从上面可以看出,SqlServer并没有内置自动跟踪数据表中的数据变化然后通知ASP.NET引擎的功能(这是肯定的,SqlServer早就出来了),所以 ASP.NET 2.0 开发团队人为地添加了自定义的 Table、Trigger、StoredProcedure 等来实现数据变化跟踪。

育空地区不必再那么麻烦了。Yukon 有一个内置的通知传递服务。该服务会通过WebServer的80端口直接通知IIS内置的监听器,然后监听器会通知ASP.NET。而且你可以注意到,上面介绍的跟踪方法只能在表级别跟踪数据变化,也就是说,ASP.NET引擎只能知道最后某个表的数据发生了变化,以及发生了哪条记录。无法跟踪更改,但育空地区的通知传递服务可实现记录级跟踪。2、 可以在当前的 ASP.NET 上实现吗?当然,我们可以先按照上面提到的第一步(或者自己定义一套规则来跟踪数据库中Table数据的变化),把这些Tables添加进去,触发器等根据葫芦画。ASP.NET的PageCache有一个VaryByCustom属性,可以让我们自己定义“缓存过期”规则(准确的说,其实就是可以让我们自定义缓存页面的版本,但是也可以间接自定义。缓存是“过期”,呵呵),只要我们重写global.asa中的HttpApplication.GetVaryByCustomString()方法,这个方法查询数据库“AspNet_SqlCacheTablesForChangeNotification”(或者根据入参字符串,如“CheckDBTable=Users” ”一个自己定义的跟踪记录表),只需让GetVaryByCustomString()方法返回“changeId”字段的值即可。

VaryByCustom 的用法在 MSDN 文档中有详细说明。下一章3、GolfClubShack演示程序在博客大厅前面的某篇文章文章中,提供了一个基于ASP.NET2.0的GolfClubShack站点演示程序,非常好东西,在里面可以看到ASP.NET2.0的很多特性的体现,包括SqlCacheDependency。网上完整的 ASP.NET 2.0 演示程序并不多。听说MS把IBuySpy移植到了ASP.NET 2.0。我不知道细节。而MS的AspNetForums 2.0在alpha阶段还是基于.Net Framework的1.1(以前我以为是基于最新的ASP.NET2.0,安装好了一半一天,晕……)。 查看全部

asp.net 抓取网页数据(ASP.NET2.0中新增的SqlCacheDependency特性使这成为了可能)

ASP.NET中的Page Cache是一个非常有用的东西,只要简单的在页面顶部添加一个OutputCache标签,就可以让页面在指定的Duration内直接输出自动保存在缓存中的页面内容,无需需要让 ASP.NET 引擎再次执行页面代码。当然,节省执行时间并不是主要原因。主要原因是如果页面内容是从数据库中取出来的,那么连接数据库和取数据的步骤就可以省略。这带来的好处是巨大的。

PageCache 有一个小问题。比如很多ASP.NET论坛的首页使用PageCache,所以一个版本发布的最新帖子不会立即反映在首页,需要等待一段时间。虽然有点不情愿,但在某些情况下(例如 eBay 用来显示物品拍卖状态的页面),这种延迟是不允许的。

也就是说,ASP.NET中的Cache不能根据数据库中对应的数据自动改变,对应的Cache就过期了。ASP.NET 2.0 中的新 SqlCacheDependency 功能使这成为可能。. (当然,只要了解了ASP.NET2.0中的一般实现,就可以基于ASP.NET1.0实现这个特性,后面会总结对应的方法。)

要在 ASP.NET 2.0 中应用 SqlCacheDependency 功能,步骤如下(基于您手头的 Whidbey PDC 版本):

1、 使数据库支持SqlCacheDependency

在.Net Framework1.2(一般是WINDOWS/Microsoft.NET/Framework/v1.2.30703)的安装目录下,有一个aspnet_regsqlcache.exe,这个命令行工具允许我们的 SqlServer 7.0 或 SqlServer 2000 支持 SqlCacheDependency 特性,

首先:“aspnet_regsqlcache -S 服务器名 -U 登录ID -P 密码 -d 数据库名 -ed”,该命令使指定数据库支持SqlCacheDependency,

然后我们添加要跟踪的数据表:“aspnet_regsqlcache -S 服务器名 -U 登录ID -P 密码 -d 数据库名 -t 要跟踪的数据表名 -et”,该命令启用指定表支持SqlCache 依赖关系。

它在幕后做什么?

首先,它在指定的数据库中创建一个新表,名为

“AspNet_SqlCacheTablesForChangeNotification”,这个表有3个字段,“tableName”记录要跟踪的数据表的名称,“notificationCreated”记录开始跟踪的时间,“changeId”是一个int类型的字段,每当跟踪数据的数据表发生变化时,该字段的值加1。它还在指定的数据库中添加了几个存储过程,以允许ASP.NET引擎查询被跟踪数据表的状态。然后,它会在我们要跟踪的Table中添加几个Trigger,分别对应Insert、Update和Delete操作。这些Triggers的语句很简单,就是“AspNet_SqlCacheTablesForChangeNotification”中对应的“tableName”字段

默认情况下,这个存储过程每 500 毫秒执行一次,但是这个间隔可以在 web.config 中修改。我的经验是,这个查询操作也是非常耗费资源的,呵呵。2、 web.config 配置 web.config 中的配置再简单不过了3、 在页面的 outputCache 标签中指定 SqlCacheDependency 属性: 只要在这个tracked上执行Insert、Update、Delete表操作,数据表上的Trigger会修改数据库中“AspNet_SqlCacheTablesForChangeNotification”表中对应记录对应的“changId”字段值,然后ASP.NET引擎获取新值就知道跟踪表已更改。,这会自动使该页面的缓存无效。下一个故事1、育空地区呢?从上面可以看出,SqlServer并没有内置自动跟踪数据表中的数据变化然后通知ASP.NET引擎的功能(这是肯定的,SqlServer早就出来了),所以 ASP.NET 2.0 开发团队人为地添加了自定义的 Table、Trigger、StoredProcedure 等来实现数据变化跟踪。

育空地区不必再那么麻烦了。Yukon 有一个内置的通知传递服务。该服务会通过WebServer的80端口直接通知IIS内置的监听器,然后监听器会通知ASP.NET。而且你可以注意到,上面介绍的跟踪方法只能在表级别跟踪数据变化,也就是说,ASP.NET引擎只能知道最后某个表的数据发生了变化,以及发生了哪条记录。无法跟踪更改,但育空地区的通知传递服务可实现记录级跟踪。2、 可以在当前的 ASP.NET 上实现吗?当然,我们可以先按照上面提到的第一步(或者自己定义一套规则来跟踪数据库中Table数据的变化),把这些Tables添加进去,触发器等根据葫芦画。ASP.NET的PageCache有一个VaryByCustom属性,可以让我们自己定义“缓存过期”规则(准确的说,其实就是可以让我们自定义缓存页面的版本,但是也可以间接自定义。缓存是“过期”,呵呵),只要我们重写global.asa中的HttpApplication.GetVaryByCustomString()方法,这个方法查询数据库“AspNet_SqlCacheTablesForChangeNotification”(或者根据入参字符串,如“CheckDBTable=Users” ”一个自己定义的跟踪记录表),只需让GetVaryByCustomString()方法返回“changeId”字段的值即可。

VaryByCustom 的用法在 MSDN 文档中有详细说明。下一章3、GolfClubShack演示程序在博客大厅前面的某篇文章文章中,提供了一个基于ASP.NET2.0的GolfClubShack站点演示程序,非常好东西,在里面可以看到ASP.NET2.0的很多特性的体现,包括SqlCacheDependency。网上完整的 ASP.NET 2.0 演示程序并不多。听说MS把IBuySpy移植到了ASP.NET 2.0。我不知道细节。而MS的AspNetForums 2.0在alpha阶段还是基于.Net Framework的1.1(以前我以为是基于最新的ASP.NET2.0,安装好了一半一天,晕……)。

asp.net 抓取网页数据( 什么是Sitemap?Sitemap.Net可方便管理员通知(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-03-12 19:11

什么是Sitemap?Sitemap.Net可方便管理员通知(组图))

首先我要说明一下:Asp.Net内置的Sitemap和这里说的Sitemap是完全不一样的。Asp.Net中的Sitemap主要是用来导航用户的,这里所说的Sitemap是用来引导搜索引擎爬虫的。

我们来看看官方的解释:

什么是站点地图?

站点地图允许管理员通知搜索引擎他们 网站 可以抓取哪些页面。在最简单的形式中,Sitepmap 是一个 XML 文件,其中列出了 网站 中的 URL 和有关每个 URL 的其他元数据(上次更新时间、更改频率以及相对于 网站 其他 URL 的重要性等),以便搜索引擎可以更智能地抓取 网站。

网络爬虫通常通过 网站 和其他 网站 中的链接来查找网页。站点地图提供此数据以允许支持站点地图的抓取工具抓取站点地图提供的所有网址,并了解哪些网址使用相关元数据。使用 Sitemap 协议并不能保证页面会被搜索引擎收录,但它会为网络爬虫提供一些提示,以便它们可以更有效地爬取 网站。

站点地图 0.90 是根据 Attribution-ShareAlike Creative Commons License 条款提供的,并被包括 Google、Yahoo! 在内的许多供应商广泛使用和支持。和微软。

引:

综上所述,提供Sitemap是一种辅助搜索引擎爬虫收录网站的手段。没有Sitemap,你的网站就是收录,但是有了Sitemap,收录会更全面、更准确。

除了提供网址,最重要的是提供页面的更新时间戳,以及网站关注和更新回访频率建议,让搜索引擎更准确的掌握你的网站@ >。

如何实现Sitemap的自动生成?

有很多开箱即用的生成器:

但是,在 Asp.Net 中,并没有官方的生成工具。搜索“Asp.Net Sitemap”也发现了很多Asp.Net内置的Sitemap功能介绍页面。

因此,我希望自己实现一个Asp.Net Sitemap 生成工具。并且希望这个工具能够与Asp.Net同步交互更新数据,保证数据的及时性;而大多数其他生成器就像一个私人爬虫,你需要手动释放它来爬取你的 网站 来为整个站点生成站点地图,我不喜欢。

Xml站点地图

这是我实现的站点地图生成工具。简单说一下实现方法:

通过数据库存储站点、页面集合、页面数据:

在 Asp.Net网站 中,在添加、删除或修改数据时,调用站点地图公开的方法来更新数据库数据。XML 格式的 Sitemap 通过 Ashx 输出,供搜索引擎爬虫读取。

在文章的最后我会分享这个项目的下载链接,然后我会谈谈如何使用这个项目。

如何部署?

我将提供以下文件用于在现有 Asp.Net网站 中部署此功能:

首先参考 XmlSitemap.dll。

然后通过“添加现有项”将 XMLSiteMap.ashx.cs 和 XMLSiteMap.ashx 添加到项目中。

然后通过“添加现有项”将 SiteMap.mdf 添加到项目的 App_Data 目录中。

在 Web.Config 中指定 SiteMap.mdf 的数据库连接字符串:

连接字符串>

在项目中添加一个新的 Global.asax 文件(如果之前没有创建过这个文件)并在它的 Application_Start 中初始化它:

蓝色高亮部分是上面Web.Config中指定的SiteMap.mdf的数据库连接字符串;

黄色高亮部分是你的网站名字,每次提交数据都会用到;

绿色突出显示的部分是您网站的 URL,每个新的 URL 数据必须位于该 URL 的域名下。

如何使用?

我们将模拟使用按钮添加数据:

protected void Button1_Click(对象发送者,EventArgs e)

{

var id=Guid.NewGuid();

Sitemap.Add Page("MySite", id, Path.Combine("", "Page.aspx?ID=" + id), 0.5, 更新频率。每日);

}

注意:这里只是为了测试,所以临时生成了一个Guid传入sitemap,但在实际使用中,应该和你原来数据入口的Guid一起传入,因为你以后可能会更新,删除操作,如果你想同时在站点地图中体现它,你还必须使用它的 Guid 作为标识符来找到它。

当您经常单击此按钮时,会在站点地图中添加多条数据。您可以通过访问 XmlSiteMap.ashx?Site=MySite 查看当前页面采集列表:

Url 地址是页面集合的 URL。由于页面数据量没有达到页面集合的上限,所以目前只有一个页面集合。

访问页面集合的 URL:

这里是每个页面的详细地址和相关信息列表。

除了添加数据,还有更新、删除等方法。由于都是中文写的,很容易理解,这里就不一一演示了:

下载

部署文件:

示例网站项目源码:

XmlSitemap 源代码:

本文的XPS版本:

来自“ITPUB博客”,链接:如需转载,请注明出处,否则追究法律责任。

转载于: 查看全部

asp.net 抓取网页数据(

什么是Sitemap?Sitemap.Net可方便管理员通知(组图))

首先我要说明一下:Asp.Net内置的Sitemap和这里说的Sitemap是完全不一样的。Asp.Net中的Sitemap主要是用来导航用户的,这里所说的Sitemap是用来引导搜索引擎爬虫的。

我们来看看官方的解释:

什么是站点地图?

站点地图允许管理员通知搜索引擎他们 网站 可以抓取哪些页面。在最简单的形式中,Sitepmap 是一个 XML 文件,其中列出了 网站 中的 URL 和有关每个 URL 的其他元数据(上次更新时间、更改频率以及相对于 网站 其他 URL 的重要性等),以便搜索引擎可以更智能地抓取 网站。

网络爬虫通常通过 网站 和其他 网站 中的链接来查找网页。站点地图提供此数据以允许支持站点地图的抓取工具抓取站点地图提供的所有网址,并了解哪些网址使用相关元数据。使用 Sitemap 协议并不能保证页面会被搜索引擎收录,但它会为网络爬虫提供一些提示,以便它们可以更有效地爬取 网站。

站点地图 0.90 是根据 Attribution-ShareAlike Creative Commons License 条款提供的,并被包括 Google、Yahoo! 在内的许多供应商广泛使用和支持。和微软。

引:

综上所述,提供Sitemap是一种辅助搜索引擎爬虫收录网站的手段。没有Sitemap,你的网站就是收录,但是有了Sitemap,收录会更全面、更准确。

除了提供网址,最重要的是提供页面的更新时间戳,以及网站关注和更新回访频率建议,让搜索引擎更准确的掌握你的网站@ >。

如何实现Sitemap的自动生成?

有很多开箱即用的生成器:

但是,在 Asp.Net 中,并没有官方的生成工具。搜索“Asp.Net Sitemap”也发现了很多Asp.Net内置的Sitemap功能介绍页面。

因此,我希望自己实现一个Asp.Net Sitemap 生成工具。并且希望这个工具能够与Asp.Net同步交互更新数据,保证数据的及时性;而大多数其他生成器就像一个私人爬虫,你需要手动释放它来爬取你的 网站 来为整个站点生成站点地图,我不喜欢。

Xml站点地图

这是我实现的站点地图生成工具。简单说一下实现方法:

通过数据库存储站点、页面集合、页面数据:

在 Asp.Net网站 中,在添加、删除或修改数据时,调用站点地图公开的方法来更新数据库数据。XML 格式的 Sitemap 通过 Ashx 输出,供搜索引擎爬虫读取。

在文章的最后我会分享这个项目的下载链接,然后我会谈谈如何使用这个项目。

如何部署?

我将提供以下文件用于在现有 Asp.Net网站 中部署此功能:

首先参考 XmlSitemap.dll。

然后通过“添加现有项”将 XMLSiteMap.ashx.cs 和 XMLSiteMap.ashx 添加到项目中。

然后通过“添加现有项”将 SiteMap.mdf 添加到项目的 App_Data 目录中。

在 Web.Config 中指定 SiteMap.mdf 的数据库连接字符串:

连接字符串>

在项目中添加一个新的 Global.asax 文件(如果之前没有创建过这个文件)并在它的 Application_Start 中初始化它:

蓝色高亮部分是上面Web.Config中指定的SiteMap.mdf的数据库连接字符串;

黄色高亮部分是你的网站名字,每次提交数据都会用到;

绿色突出显示的部分是您网站的 URL,每个新的 URL 数据必须位于该 URL 的域名下。

如何使用?

我们将模拟使用按钮添加数据:

protected void Button1_Click(对象发送者,EventArgs e)

{

var id=Guid.NewGuid();

Sitemap.Add Page("MySite", id, Path.Combine("", "Page.aspx?ID=" + id), 0.5, 更新频率。每日);

}

注意:这里只是为了测试,所以临时生成了一个Guid传入sitemap,但在实际使用中,应该和你原来数据入口的Guid一起传入,因为你以后可能会更新,删除操作,如果你想同时在站点地图中体现它,你还必须使用它的 Guid 作为标识符来找到它。

当您经常单击此按钮时,会在站点地图中添加多条数据。您可以通过访问 XmlSiteMap.ashx?Site=MySite 查看当前页面采集列表:

Url 地址是页面集合的 URL。由于页面数据量没有达到页面集合的上限,所以目前只有一个页面集合。

访问页面集合的 URL:

这里是每个页面的详细地址和相关信息列表。

除了添加数据,还有更新、删除等方法。由于都是中文写的,很容易理解,这里就不一一演示了:

下载

部署文件:

示例网站项目源码:

XmlSitemap 源代码:

本文的XPS版本:

来自“ITPUB博客”,链接:如需转载,请注明出处,否则追究法律责任。

转载于:

asp.net 抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-03-08 00:05

你想知道爬取网页源码的三种实现方式的相关内容吗?在这篇文章中,我将为大家讲解爬取网页源码的相关知识以及一些代码示例。欢迎阅读和指正。先把重点:爬取、网页、源码,一起来学习吧。

方法1更推荐

///

/// 用HttpWebRequest取得网页源码

/// 对于带BOM的网页很有效,不管是什么编码都能正确识别

///

/// 网页地址"

/// 返回网页源文件

public static string GetHtmlSource2(string url)

{

//处理内容

string html = "";

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.Accept = "*/*"; //接受任意文件

request.UserAgent = "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.1.4322)"; // 模拟使用IE在浏览 http://www.52mvc.com

request.AllowAutoRedirect = true;//是否允许302

//request.CookieContainer = new CookieContainer();//cookie容器,

request.Referer = url; //当前页面的引用

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, Encoding.Default);

html = reader.ReadToEnd();

stream.Close();

return html;

}

方法二

using System;

using System.Collections.Generic;

using System.Linq;

using System.Web;

using System.IO;

using System.Text;

using System.Net;

namespace MySql

{

public class GetHttpData

{

public static string GetHttpData2(string Url)

{

string sException = null;

string sRslt = null;

WebResponse oWebRps = null;

WebRequest oWebRqst = WebRequest.Create(Url);

oWebRqst.Timeout = 50000;

try

{

oWebRps = oWebRqst.GetResponse();

}

catch (WebException e)

{

sException = e.Message.ToString();

}

catch (Exception e)

{

sException = e.ToString();

}

finally

{

if (oWebRps != null)

{

StreamReader oStreamRd = new StreamReader(oWebRps.GetResponseStream(), Encoding.GetEncoding("utf-8"));

sRslt = oStreamRd.ReadToEnd();

oStreamRd.Close();

oWebRps.Close();

}

}

return sRslt;

}

}

}

方法三

<p>

public static string getHtml(string url, params string [] charSets)//url是要访问的网站地址,charSet是目标网页的编码,如果传入的是null或者"",那就自动分析网页的编码

{

try

{

string charSet = null;

if (charSets.Length == 1) {

charSet = charSets[0];

}

WebClient myWebClient = new WebClient(); //创建WebClient实例myWebClient

// 需要注意的:

//有的网页可能下不下来,有种种原因比如需要cookie,编码问题等等

//这是就要具体问题具体分析比如在头部加入cookie

// webclient.Headers.Add("Cookie", cookie);

//这样可能需要一些重载方法。根据需要写就可以了

//获取或设置用于对向 Internet 资源的请求进行身份验证的网络凭据。

myWebClient.Credentials = CredentialCache.DefaultCredentials;

//如果服务器要验证用户名,密码

//NetworkCredential mycred = new NetworkCredential(struser, strpassword);

//myWebClient.Credentials = mycred;

//从资源下载数据并返回字节数组。(加@是因为网址中间有"/"符号)

byte[] myDataBuffer = myWebClient.DownloadData(url);

string strWebData = Encoding.Default.GetString(myDataBuffer);

//获取网页字符编码描述信息

Match charSetMatch = Regex.Match(strWebData, " 查看全部

asp.net 抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

你想知道爬取网页源码的三种实现方式的相关内容吗?在这篇文章中,我将为大家讲解爬取网页源码的相关知识以及一些代码示例。欢迎阅读和指正。先把重点:爬取、网页、源码,一起来学习吧。

方法1更推荐

///

/// 用HttpWebRequest取得网页源码

/// 对于带BOM的网页很有效,不管是什么编码都能正确识别

///

/// 网页地址"

/// 返回网页源文件

public static string GetHtmlSource2(string url)

{

//处理内容

string html = "";

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.Accept = "*/*"; //接受任意文件

request.UserAgent = "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.1.4322)"; // 模拟使用IE在浏览 http://www.52mvc.com

request.AllowAutoRedirect = true;//是否允许302

//request.CookieContainer = new CookieContainer();//cookie容器,

request.Referer = url; //当前页面的引用

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, Encoding.Default);

html = reader.ReadToEnd();

stream.Close();

return html;

}

方法二

using System;

using System.Collections.Generic;

using System.Linq;

using System.Web;

using System.IO;

using System.Text;

using System.Net;

namespace MySql

{

public class GetHttpData

{

public static string GetHttpData2(string Url)

{

string sException = null;

string sRslt = null;

WebResponse oWebRps = null;

WebRequest oWebRqst = WebRequest.Create(Url);

oWebRqst.Timeout = 50000;

try

{

oWebRps = oWebRqst.GetResponse();

}

catch (WebException e)

{

sException = e.Message.ToString();

}

catch (Exception e)

{

sException = e.ToString();

}

finally

{

if (oWebRps != null)

{

StreamReader oStreamRd = new StreamReader(oWebRps.GetResponseStream(), Encoding.GetEncoding("utf-8"));

sRslt = oStreamRd.ReadToEnd();

oStreamRd.Close();

oWebRps.Close();

}

}

return sRslt;

}

}

}

方法三

<p>

public static string getHtml(string url, params string [] charSets)//url是要访问的网站地址,charSet是目标网页的编码,如果传入的是null或者"",那就自动分析网页的编码

{

try

{

string charSet = null;

if (charSets.Length == 1) {

charSet = charSets[0];

}

WebClient myWebClient = new WebClient(); //创建WebClient实例myWebClient

// 需要注意的:

//有的网页可能下不下来,有种种原因比如需要cookie,编码问题等等

//这是就要具体问题具体分析比如在头部加入cookie

// webclient.Headers.Add("Cookie", cookie);

//这样可能需要一些重载方法。根据需要写就可以了

//获取或设置用于对向 Internet 资源的请求进行身份验证的网络凭据。

myWebClient.Credentials = CredentialCache.DefaultCredentials;

//如果服务器要验证用户名,密码

//NetworkCredential mycred = new NetworkCredential(struser, strpassword);

//myWebClient.Credentials = mycred;

//从资源下载数据并返回字节数组。(加@是因为网址中间有"/"符号)

byte[] myDataBuffer = myWebClient.DownloadData(url);

string strWebData = Encoding.Default.GetString(myDataBuffer);

//获取网页字符编码描述信息

Match charSetMatch = Regex.Match(strWebData, "

asp.net 抓取网页数据( EXCEL教程EXCEL函数EXCEL透视表EXCEL实用技巧EXCEL2010-04-0811)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2022-03-05 22:03

EXCEL教程EXCEL函数EXCEL透视表EXCEL实用技巧EXCEL2010-04-0811)

ASP 网页抓取

网络抓取也称为网络爬虫。我们用它来获取target网站和target模块的最新动态,可以直接抓取。我们提供爬取目标的url地址,然后编写一个方法来爬取目标url。

//获取某个URL下的内容

public string getContextByUrl(string url)

{

WebRequest request = WebRequest.Create(url);

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream dataStream = response.GetResponseStream();

StreamReader reader = new StreamReader(dataStream,Encoding.Default);

string result = reader.ReadToEnd();

reader.Close();

dataStream.Flush();

dataStream.Close();

response.Close();

return result; }

然后我们调用这个方法

string result = getContextByUrl(url);

string name = result.Substring(result.IndexOf("tb-detail-hd"), 450);

string aa = name.Substring(name.IndexOf(""), 50);

string price = null;

if (url.Contains("detail"))

{

price = result.Substring(result.IndexOf("<strong>"), 50);

}

else if (url.Contains("item"))

{

price = result.Substring(result.IndexOf("<strong class>"), 50);

}

Label1.Text = aa;

Label2.Text = price;

来源链接:

张贴@2013-04-08 11:40Jason.Lau 阅读(665)评论(0)编辑 查看全部

asp.net 抓取网页数据(

EXCEL教程EXCEL函数EXCEL透视表EXCEL实用技巧EXCEL2010-04-0811)

ASP 网页抓取

网络抓取也称为网络爬虫。我们用它来获取target网站和target模块的最新动态,可以直接抓取。我们提供爬取目标的url地址,然后编写一个方法来爬取目标url。

//获取某个URL下的内容

public string getContextByUrl(string url)

{

WebRequest request = WebRequest.Create(url);

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream dataStream = response.GetResponseStream();

StreamReader reader = new StreamReader(dataStream,Encoding.Default);

string result = reader.ReadToEnd();

reader.Close();

dataStream.Flush();

dataStream.Close();

response.Close();

return result; }

然后我们调用这个方法

string result = getContextByUrl(url);

string name = result.Substring(result.IndexOf("tb-detail-hd"), 450);

string aa = name.Substring(name.IndexOf(""), 50);

string price = null;

if (url.Contains("detail"))

{

price = result.Substring(result.IndexOf("<strong>"), 50);

}

else if (url.Contains("item"))

{

price = result.Substring(result.IndexOf("<strong class>"), 50);

}

Label1.Text = aa;

Label2.Text = price;

来源链接:

张贴@2013-04-08 11:40Jason.Lau 阅读(665)评论(0)编辑

asp.net 抓取网页数据(基于反向链接(BackLink)的网页分析算法())

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-03-03 16:17

爬虫简介

网络爬虫(也称为网络蜘蛛、网络机器人,或者在 FOAF 社区中更常称为网络追踪器)是一种程序或脚本,它根据某些规则自动从万维网上爬取信息。其他不太常用的名称是 ant、autoindex、emulator 或 worm。

算法分析

网页分析算法可以分为三类:基于网络拓扑、基于网页内容和基于用户访问行为。

拓扑分析算法

基于网页之间的链接,通过已知的网页或数据,评估与其有直接或间接链接关系的对象(可以是网页或网站等)的算法。进一步分为三种:网页粒度、网站粒度和网页块粒度。

(1)网页粒度分析算法

PageRank 和 HITS 算法是最常见的链接分析算法。两者都是通过网页间链接度的递归归一化计算得到每个网页的重要性。PageRank算法虽然考虑了用户访问行为的随机性和Sink网页的存在性,但忽略了大部分用户访问的目的性,即网页和查询主题链接的相关性。针对这个问题,HITS算法提出了两个关键概念:权威网页(authority)和中心网页(hub)。

基于链接的爬取问题是相关页面的主题组之间存在隧道现象,即爬取路径上很多偏离主题的页面也指向目标页面,局部评价策略中断了爬取行为当前路径。文献提出了一种基于反向链接(BackLink)的层次上下文模型(Context Model),用于将目标网页一定物理跳半径内的网页拓扑图的中心Layer0描述为目标网页。目标网页的物理跳数分层,从外层网页到内层网页的链接称为反向链接。

(2)网站粒度分析算法

网站粒度资源发现和管理策略也比网页粒度更简单有效。网站粒度爬取的关键是站点的划分和SiteRank的计算。SiteRank的计算方法与PageRank类似,但需要对网站之间的链接进行一定程度的抽象,并在一定模型下计算链接的权重。

网站划分分为两种:按域名划分和按IP地址划分。文献讨论在分布式情况下,通过将站点除以同一域名下不同主机和服务器的IP地址,构建站点地图,并采用类似于PageRank的方法来评估SiteRank。同时,根据每个站点不同文件的分布情况,构建文档图,结合SiteRank分布式计算得到DocRank。文献证明,使用分布式SiteRank计算不仅大大降低了单个站点的算法成本,而且克服了单个站点对全网覆盖范围有限的缺点。

(3)网页块粒度分析算法

一个页面往往收录多个指向其他页面的链接,而这些链接中只有一部分指向与主题相关的网页,或者根据网页的链接锚文本表明其重要性高。但是在PageRank和HITS算法中,这些链接是没有区分的,所以往往会给网页分析带来广告等噪声链接的干扰。页面块级链接分析算法的基本思想是通过VIPS页面分割算法将页面划分为不同的页面块(page blocks),然后为这些页面建立page to block和block to page链接块。矩阵,分别表示为 Z 和 X。因此,页到页图上的页块级别的PageRank为W§=X×Z;块到块图上的 BlockRank 为 W(b)=Z×X。

网页内容分析算法

基于网页内容的分析算法是指利用网页内容的特征(文本、数据等资源)对网页进行评价。网页的内容已经从基于超文本的内容演变为动态页面(或称为Hidden Web)数据,后者的数据量约为直接可见页面数据(PIW,Publicly Indexable Web)的400~500%。次。另一方面,多媒体数据、Web Service等各种形式的网络资源日益丰富。因此,基于网页内容的分析算法也从最初的相对简单的文本检索方法发展到综合应用包括网页数据提取、机器学习、数据挖掘、语义理解等多种方法。本节根据网页数据的不同形式,基于网页内容的分析算法分为以下三类:第一类是针对以文本和超链接为主的非结构化或非常简单的网页;第二个是结构化网页。对于数据源(如RDBMS)动态生成的页面,不能直接批量访问数据;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。数据不能直接批量访问;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。数据不能直接批量访问;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。

基于文本的网页分析算法

(1)纯文本分类和聚类算法

它在很大程度上借鉴了文本检索的技术。文本分析算法可以快速有效地对网页进行分类和聚类,但很少单独使用,因为它们忽略了网页之间和网页内的结构信息。

(2)超文本分类和聚类算法

根据网页链接的网页的相关类型对网页进行分类,并通过关联的网页推断网页的类型。 查看全部

asp.net 抓取网页数据(基于反向链接(BackLink)的网页分析算法())

爬虫简介

网络爬虫(也称为网络蜘蛛、网络机器人,或者在 FOAF 社区中更常称为网络追踪器)是一种程序或脚本,它根据某些规则自动从万维网上爬取信息。其他不太常用的名称是 ant、autoindex、emulator 或 worm。

算法分析

网页分析算法可以分为三类:基于网络拓扑、基于网页内容和基于用户访问行为。

拓扑分析算法

基于网页之间的链接,通过已知的网页或数据,评估与其有直接或间接链接关系的对象(可以是网页或网站等)的算法。进一步分为三种:网页粒度、网站粒度和网页块粒度。

(1)网页粒度分析算法

PageRank 和 HITS 算法是最常见的链接分析算法。两者都是通过网页间链接度的递归归一化计算得到每个网页的重要性。PageRank算法虽然考虑了用户访问行为的随机性和Sink网页的存在性,但忽略了大部分用户访问的目的性,即网页和查询主题链接的相关性。针对这个问题,HITS算法提出了两个关键概念:权威网页(authority)和中心网页(hub)。

基于链接的爬取问题是相关页面的主题组之间存在隧道现象,即爬取路径上很多偏离主题的页面也指向目标页面,局部评价策略中断了爬取行为当前路径。文献提出了一种基于反向链接(BackLink)的层次上下文模型(Context Model),用于将目标网页一定物理跳半径内的网页拓扑图的中心Layer0描述为目标网页。目标网页的物理跳数分层,从外层网页到内层网页的链接称为反向链接。

(2)网站粒度分析算法

网站粒度资源发现和管理策略也比网页粒度更简单有效。网站粒度爬取的关键是站点的划分和SiteRank的计算。SiteRank的计算方法与PageRank类似,但需要对网站之间的链接进行一定程度的抽象,并在一定模型下计算链接的权重。

网站划分分为两种:按域名划分和按IP地址划分。文献讨论在分布式情况下,通过将站点除以同一域名下不同主机和服务器的IP地址,构建站点地图,并采用类似于PageRank的方法来评估SiteRank。同时,根据每个站点不同文件的分布情况,构建文档图,结合SiteRank分布式计算得到DocRank。文献证明,使用分布式SiteRank计算不仅大大降低了单个站点的算法成本,而且克服了单个站点对全网覆盖范围有限的缺点。

(3)网页块粒度分析算法

一个页面往往收录多个指向其他页面的链接,而这些链接中只有一部分指向与主题相关的网页,或者根据网页的链接锚文本表明其重要性高。但是在PageRank和HITS算法中,这些链接是没有区分的,所以往往会给网页分析带来广告等噪声链接的干扰。页面块级链接分析算法的基本思想是通过VIPS页面分割算法将页面划分为不同的页面块(page blocks),然后为这些页面建立page to block和block to page链接块。矩阵,分别表示为 Z 和 X。因此,页到页图上的页块级别的PageRank为W§=X×Z;块到块图上的 BlockRank 为 W(b)=Z×X。

网页内容分析算法

基于网页内容的分析算法是指利用网页内容的特征(文本、数据等资源)对网页进行评价。网页的内容已经从基于超文本的内容演变为动态页面(或称为Hidden Web)数据,后者的数据量约为直接可见页面数据(PIW,Publicly Indexable Web)的400~500%。次。另一方面,多媒体数据、Web Service等各种形式的网络资源日益丰富。因此,基于网页内容的分析算法也从最初的相对简单的文本检索方法发展到综合应用包括网页数据提取、机器学习、数据挖掘、语义理解等多种方法。本节根据网页数据的不同形式,基于网页内容的分析算法分为以下三类:第一类是针对以文本和超链接为主的非结构化或非常简单的网页;第二个是结构化网页。对于数据源(如RDBMS)动态生成的页面,不能直接批量访问数据;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。数据不能直接批量访问;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。数据不能直接批量访问;第三类数据介于第一类和第二类数据之间,结构更好,表明它遵循一定的模式或风格。并且可以直接访问。

基于文本的网页分析算法

(1)纯文本分类和聚类算法

它在很大程度上借鉴了文本检索的技术。文本分析算法可以快速有效地对网页进行分类和聚类,但很少单独使用,因为它们忽略了网页之间和网页内的结构信息。

(2)超文本分类和聚类算法

根据网页链接的网页的相关类型对网页进行分类,并通过关联的网页推断网页的类型。

asp.net 抓取网页数据(什么是Sitemap?Sitemap.Net可方便管理员通知(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-02-28 07:19

首先我要说明一下:Asp.Net内置的Sitemap和这里说的Sitemap是完全不一样的。Asp.Net中的Sitemap主要是用来导航用户的,这里所说的Sitemap是用来引导搜索引擎爬虫的。

我们来看看官方的解释:

什么是站点地图?

站点地图允许管理员通知搜索引擎他们 网站 可以抓取哪些页面。在最简单的形式中,Sitepmap 是一个 XML 文件,其中列出了 网站 中的 URL 和有关每个 URL 的其他元数据(上次更新时间、更改频率以及相对于 网站 其他 URL 的重要性等),以便搜索引擎可以更智能地抓取 网站。

网络爬虫通常通过 网站 和其他 网站 中的链接来查找网页。站点地图提供此数据以允许支持站点地图的抓取工具抓取站点地图提供的所有网址,并了解哪些网址使用相关元数据。使用 Sitemap 协议并不能保证页面会被搜索引擎收录,但它会为网络爬虫提供一些提示,以便它们可以更有效地爬取 网站。

站点地图 0.90 是根据 Attribution-ShareAlike Creative Commons License 条款提供的,并被包括 Google、Yahoo! 在内的许多供应商广泛使用和支持。和微软。

引:

综上所述,提供Sitemap是一种辅助搜索引擎爬虫收录网站的手段。没有Sitemap,你的网站就是收录,但是有了Sitemap,收录会更全面、更准确。

除了提供网址,最重要的是提供页面的更新时间戳,以及网站关注和更新回访频率建议,让搜索引擎更准确的掌握你的网站@ >。

如何实现Sitemap的自动生成?

有很多开箱即用的生成器:

但是,在 Asp.Net 中,并没有官方的生成工具。搜索“Asp.Net Sitemap”也发现了很多Asp.Net内置的Sitemap功能介绍页面。

因此,我希望自己实现一个Asp.Net Sitemap 生成工具。并且希望这个工具能够与Asp.Net同步交互更新数据,保证数据的及时性;而大多数其他生成器就像一个私人爬虫,你需要手动释放它来爬取你的 网站 来为整个站点生成站点地图,我不喜欢。

Xml站点地图

这是我实现的站点地图生成工具。简单说一下实现方法:

通过数据库存储站点、页面集合、页面数据:

在 Asp.Net网站 中,在添加、删除或修改数据时,调用站点地图公开的方法来更新数据库数据。XML 格式的 Sitemap 通过 Ashx 输出,供搜索引擎爬虫读取。

在文章的最后我会分享这个项目的下载链接,然后我会谈谈如何使用这个项目。

如何部署?

我将提供以下文件用于在现有 Asp.Net网站 中部署此功能:

首先参考 XmlSitemap.dll。

然后通过“添加现有项”将 XMLSiteMap.ashx.cs 和 XMLSiteMap.ashx 添加到项目中。

然后通过“添加现有项”将 SiteMap.mdf 添加到项目的 App_Data 目录中。

在 Web.Config 中指定 SiteMap.mdf 的数据库连接字符串:

在项目中添加一个新的 Global.asax 文件(如果之前没有创建过这个文件)并在它的 Application_Start 中初始化它:

蓝色高亮部分是上面Web.Config中指定的SiteMap.mdf的数据库连接字符串;

黄色高亮部分是你的网站名字,每次提交数据都会用到;

绿色突出显示的部分是您网站的 URL,每个新的 URL 数据必须位于该 URL 的域名下。

如何使用?

我们将模拟使用按钮添加数据:

protectedvoidButton1_Click(objectsender, EventArgse)

{

varid=Guid.NewGuid();

Sitemap.Add Page("MySite", id,Path.Combine("","Page.aspx?ID="+id),0.5,Update Frequency.Daily);

}

注意:这里只是为了测试,所以临时生成了一个Guid传入sitemap,但在实际使用中,应该和你原来数据入口的Guid一起传入,因为你以后可能会更新,删除操作,如果你想同时在站点地图中体现它,你还必须使用它的 Guid 作为标识符来找到它。

当您经常单击此按钮时,会在站点地图中添加多条数据。您可以通过访问 XmlSiteMap.ashx?Site=MySite 查看当前页面采集列表:

Url 地址是页面集合的 URL。由于页面数据量没有达到页面集合的上限,所以目前只有一个页面集合。

访问页面集合的 URL:

这里是每个页面的详细地址和相关信息列表。

除了添加数据,还有更新、删除等方法。由于都是中文写的,很容易理解,这里就不一一演示了:

下载

部署文件:

示例网站项目源码:

XmlSitemap 源代码:

本文的XPS版本: 查看全部

asp.net 抓取网页数据(什么是Sitemap?Sitemap.Net可方便管理员通知(组图))

首先我要说明一下:Asp.Net内置的Sitemap和这里说的Sitemap是完全不一样的。Asp.Net中的Sitemap主要是用来导航用户的,这里所说的Sitemap是用来引导搜索引擎爬虫的。

我们来看看官方的解释:

什么是站点地图?

站点地图允许管理员通知搜索引擎他们 网站 可以抓取哪些页面。在最简单的形式中,Sitepmap 是一个 XML 文件,其中列出了 网站 中的 URL 和有关每个 URL 的其他元数据(上次更新时间、更改频率以及相对于 网站 其他 URL 的重要性等),以便搜索引擎可以更智能地抓取 网站。

网络爬虫通常通过 网站 和其他 网站 中的链接来查找网页。站点地图提供此数据以允许支持站点地图的抓取工具抓取站点地图提供的所有网址,并了解哪些网址使用相关元数据。使用 Sitemap 协议并不能保证页面会被搜索引擎收录,但它会为网络爬虫提供一些提示,以便它们可以更有效地爬取 网站。

站点地图 0.90 是根据 Attribution-ShareAlike Creative Commons License 条款提供的,并被包括 Google、Yahoo! 在内的许多供应商广泛使用和支持。和微软。

引:

综上所述,提供Sitemap是一种辅助搜索引擎爬虫收录网站的手段。没有Sitemap,你的网站就是收录,但是有了Sitemap,收录会更全面、更准确。

除了提供网址,最重要的是提供页面的更新时间戳,以及网站关注和更新回访频率建议,让搜索引擎更准确的掌握你的网站@ >。

如何实现Sitemap的自动生成?

有很多开箱即用的生成器:

但是,在 Asp.Net 中,并没有官方的生成工具。搜索“Asp.Net Sitemap”也发现了很多Asp.Net内置的Sitemap功能介绍页面。

因此,我希望自己实现一个Asp.Net Sitemap 生成工具。并且希望这个工具能够与Asp.Net同步交互更新数据,保证数据的及时性;而大多数其他生成器就像一个私人爬虫,你需要手动释放它来爬取你的 网站 来为整个站点生成站点地图,我不喜欢。

Xml站点地图

这是我实现的站点地图生成工具。简单说一下实现方法:

通过数据库存储站点、页面集合、页面数据:

在 Asp.Net网站 中,在添加、删除或修改数据时,调用站点地图公开的方法来更新数据库数据。XML 格式的 Sitemap 通过 Ashx 输出,供搜索引擎爬虫读取。

在文章的最后我会分享这个项目的下载链接,然后我会谈谈如何使用这个项目。

如何部署?

我将提供以下文件用于在现有 Asp.Net网站 中部署此功能:

首先参考 XmlSitemap.dll。

然后通过“添加现有项”将 XMLSiteMap.ashx.cs 和 XMLSiteMap.ashx 添加到项目中。

然后通过“添加现有项”将 SiteMap.mdf 添加到项目的 App_Data 目录中。

在 Web.Config 中指定 SiteMap.mdf 的数据库连接字符串:

在项目中添加一个新的 Global.asax 文件(如果之前没有创建过这个文件)并在它的 Application_Start 中初始化它:

蓝色高亮部分是上面Web.Config中指定的SiteMap.mdf的数据库连接字符串;

黄色高亮部分是你的网站名字,每次提交数据都会用到;

绿色突出显示的部分是您网站的 URL,每个新的 URL 数据必须位于该 URL 的域名下。

如何使用?

我们将模拟使用按钮添加数据:

protectedvoidButton1_Click(objectsender, EventArgse)

{

varid=Guid.NewGuid();

Sitemap.Add Page("MySite", id,Path.Combine("","Page.aspx?ID="+id),0.5,Update Frequency.Daily);

}

注意:这里只是为了测试,所以临时生成了一个Guid传入sitemap,但在实际使用中,应该和你原来数据入口的Guid一起传入,因为你以后可能会更新,删除操作,如果你想同时在站点地图中体现它,你还必须使用它的 Guid 作为标识符来找到它。

当您经常单击此按钮时,会在站点地图中添加多条数据。您可以通过访问 XmlSiteMap.ashx?Site=MySite 查看当前页面采集列表:

Url 地址是页面集合的 URL。由于页面数据量没有达到页面集合的上限,所以目前只有一个页面集合。

访问页面集合的 URL:

这里是每个页面的详细地址和相关信息列表。

除了添加数据,还有更新、删除等方法。由于都是中文写的,很容易理解,这里就不一一演示了:

下载

部署文件:

示例网站项目源码:

XmlSitemap 源代码:

本文的XPS版本:

asp.net 抓取网页数据(抓取网页数据(preurl可用来获取网页的跳转链接))

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-02-23 14:04

抓取网页数据(preurl可用来获取网页的跳转链接)可以有多种形式,有在一个元素上连接多个外键值的形式。对于获取外键值,有多种方法可以多次获取,利用assignmentcreatedal用法如下:*{id:nsmutableurlencode("your.html"),id:nsmutableurlencode("your.html"),controlvalue:"your.localhost:5683"}:1第1步:(assert),assignmentcreatedal("your.html"):map("excel",["comctrl",{id:1,controlvalue:2}]):2第2步:(check),assignmentcreatedal("your.html"):map("excel",["comctrl",{id:3,controlvalue:4}]):5第3步:(if),assignmentcreatedal("your.html"):map("excel",["comctrl",{id:4,controlvalue:5}]):6第4步:(check),assignmentcreatedal("your.html"):map("excel",["comctrl",{id:6,controlvalue:5}]):6对于controlvalue直接相加,可进行判断判断实例#/me2/include//filterlib/regexlib/setext({"comctrl":"system,comctrl"},"a.html")#。 查看全部

asp.net 抓取网页数据(抓取网页数据(preurl可用来获取网页的跳转链接))

抓取网页数据(preurl可用来获取网页的跳转链接)可以有多种形式,有在一个元素上连接多个外键值的形式。对于获取外键值,有多种方法可以多次获取,利用assignmentcreatedal用法如下:*{id:nsmutableurlencode("your.html"),id:nsmutableurlencode("your.html"),controlvalue:"your.localhost:5683"}:1第1步:(assert),assignmentcreatedal("your.html"):map("excel",["comctrl",{id:1,controlvalue:2}]):2第2步:(check),assignmentcreatedal("your.html"):map("excel",["comctrl",{id:3,controlvalue:4}]):5第3步:(if),assignmentcreatedal("your.html"):map("excel",["comctrl",{id:4,controlvalue:5}]):6第4步:(check),assignmentcreatedal("your.html"):map("excel",["comctrl",{id:6,controlvalue:5}]):6对于controlvalue直接相加,可进行判断判断实例#/me2/include//filterlib/regexlib/setext({"comctrl":"system,comctrl"},"a.html")#。

asp.net 抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 78 次浏览 • 2022-02-22 10:03

你想知道爬取网页源码的三种实现方式的相关内容吗?在这篇文章中,我将为大家讲解爬取网页源码的相关知识以及一些代码示例。欢迎阅读和指正。先把重点:爬取、网页、源码,一起来学习吧。

方法1更推荐

///

/// 用HttpWebRequest取得网页源码

/// 对于带BOM的网页很有效,不管是什么编码都能正确识别

///

/// 网页地址"

/// 返回网页源文件

public static string GetHtmlSource2(string url)

{

//处理内容

string html = "";

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.Accept = "*/*"; //接受任意文件

request.UserAgent = "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.1.4322)"; // 模拟使用IE在浏览 http://www.52mvc.com

request.AllowAutoRedirect = true;//是否允许302

//request.CookieContainer = new CookieContainer();//cookie容器,

request.Referer = url; //当前页面的引用

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, Encoding.Default);

html = reader.ReadToEnd();

stream.Close();

return html;

}

方法二

using System;

using System.Collections.Generic;

using System.Linq;

using System.Web;

using System.IO;

using System.Text;

using System.Net;

namespace MySql

{

public class GetHttpData

{

public static string GetHttpData2(string Url)

{

string sException = null;

string sRslt = null;

WebResponse oWebRps = null;

WebRequest oWebRqst = WebRequest.Create(Url);

oWebRqst.Timeout = 50000;

try

{

oWebRps = oWebRqst.GetResponse();

}

catch (WebException e)

{

sException = e.Message.ToString();

}

catch (Exception e)

{

sException = e.ToString();

}

finally

{

if (oWebRps != null)

{

StreamReader oStreamRd = new StreamReader(oWebRps.GetResponseStream(), Encoding.GetEncoding("utf-8"));

sRslt = oStreamRd.ReadToEnd();

oStreamRd.Close();

oWebRps.Close();

}

}

return sRslt;

}

}

}

方法三

<p>

public static string getHtml(string url, params string [] charSets)//url是要访问的网站地址,charSet是目标网页的编码,如果传入的是null或者"",那就自动分析网页的编码

{

try

{

string charSet = null;

if (charSets.Length == 1) {

charSet = charSets[0];

}

WebClient myWebClient = new WebClient(); //创建WebClient实例myWebClient

// 需要注意的:

//有的网页可能下不下来,有种种原因比如需要cookie,编码问题等等

//这是就要具体问题具体分析比如在头部加入cookie

// webclient.Headers.Add("Cookie", cookie);

//这样可能需要一些重载方法。根据需要写就可以了

//获取或设置用于对向 Internet 资源的请求进行身份验证的网络凭据。

myWebClient.Credentials = CredentialCache.DefaultCredentials;

//如果服务器要验证用户名,密码

//NetworkCredential mycred = new NetworkCredential(struser, strpassword);

//myWebClient.Credentials = mycred;

//从资源下载数据并返回字节数组。(加@是因为网址中间有"/"符号)

byte[] myDataBuffer = myWebClient.DownloadData(url);

string strWebData = Encoding.Default.GetString(myDataBuffer);

//获取网页字符编码描述信息

Match charSetMatch = Regex.Match(strWebData, " 查看全部

asp.net 抓取网页数据(Excel教程Excel函数Excel表格制作Excel2010Excel实用技巧Excel视频教程)

你想知道爬取网页源码的三种实现方式的相关内容吗?在这篇文章中,我将为大家讲解爬取网页源码的相关知识以及一些代码示例。欢迎阅读和指正。先把重点:爬取、网页、源码,一起来学习吧。

方法1更推荐

///

/// 用HttpWebRequest取得网页源码

/// 对于带BOM的网页很有效,不管是什么编码都能正确识别

///

/// 网页地址"

/// 返回网页源文件

public static string GetHtmlSource2(string url)

{

//处理内容

string html = "";

HttpWebRequest request = (HttpWebRequest)WebRequest.Create(url);

request.Accept = "*/*"; //接受任意文件

request.UserAgent = "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.2; .NET CLR 1.1.4322)"; // 模拟使用IE在浏览 http://www.52mvc.com

request.AllowAutoRedirect = true;//是否允许302

//request.CookieContainer = new CookieContainer();//cookie容器,

request.Referer = url; //当前页面的引用

HttpWebResponse response = (HttpWebResponse)request.GetResponse();

Stream stream = response.GetResponseStream();

StreamReader reader = new StreamReader(stream, Encoding.Default);

html = reader.ReadToEnd();

stream.Close();

return html;

}

方法二

using System;

using System.Collections.Generic;

using System.Linq;

using System.Web;

using System.IO;

using System.Text;

using System.Net;

namespace MySql

{

public class GetHttpData

{

public static string GetHttpData2(string Url)

{

string sException = null;

string sRslt = null;

WebResponse oWebRps = null;

WebRequest oWebRqst = WebRequest.Create(Url);

oWebRqst.Timeout = 50000;

try

{

oWebRps = oWebRqst.GetResponse();

}

catch (WebException e)

{

sException = e.Message.ToString();

}

catch (Exception e)

{

sException = e.ToString();

}

finally

{

if (oWebRps != null)

{

StreamReader oStreamRd = new StreamReader(oWebRps.GetResponseStream(), Encoding.GetEncoding("utf-8"));

sRslt = oStreamRd.ReadToEnd();

oStreamRd.Close();

oWebRps.Close();

}

}

return sRslt;

}

}

}

方法三

<p>

public static string getHtml(string url, params string [] charSets)//url是要访问的网站地址,charSet是目标网页的编码,如果传入的是null或者"",那就自动分析网页的编码

{

try

{

string charSet = null;

if (charSets.Length == 1) {

charSet = charSets[0];

}

WebClient myWebClient = new WebClient(); //创建WebClient实例myWebClient

// 需要注意的:

//有的网页可能下不下来,有种种原因比如需要cookie,编码问题等等

//这是就要具体问题具体分析比如在头部加入cookie

// webclient.Headers.Add("Cookie", cookie);

//这样可能需要一些重载方法。根据需要写就可以了

//获取或设置用于对向 Internet 资源的请求进行身份验证的网络凭据。

myWebClient.Credentials = CredentialCache.DefaultCredentials;

//如果服务器要验证用户名,密码

//NetworkCredential mycred = new NetworkCredential(struser, strpassword);

//myWebClient.Credentials = mycred;

//从资源下载数据并返回字节数组。(加@是因为网址中间有"/"符号)

byte[] myDataBuffer = myWebClient.DownloadData(url);

string strWebData = Encoding.Default.GetString(myDataBuffer);

//获取网页字符编码描述信息

Match charSetMatch = Regex.Match(strWebData, "

asp.net 抓取网页数据(抓取网页数据的url值设置为浏览器上的哪个useragent)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-02-20 05:01

抓取网页数据的url就像通过一本书的目录,url中有规则,一个url里的数据就是一本书,抓取一页的数据后,以这页为起点继续抓取下一页的数据,以此类推。举个例子,先抓取一页,再抓取一页不就可以了。对于url来说,最后有个空白,对应的就是url的目录,里就是一个页数。只要下载下来后通过,添加到directory,完全可以获取。不过要获取一整页的数据需要提前做好读取内容的准备工作,如果不能做好准备工作,是抓取不到全部数据的。

这个上手是比较简单的。一般的办法是先抓取网页本身的内容再与目录表(workbook)对照,抓取数据。另外在爬虫中注意修改headers中useragent的值,将useragent的值设置为浏览器上的哪个useragent。

首先asp。net后端程序并不一定需要必须是浏览器的脚本,所以不一定需要能正常抓取页面的可以这样理解,你抓取一页,然后保存到数据库,然后再接下来要抓取网页列表页,而如果要抓取列表页的数据是可以做到很简单的,具体方法自己百度一下,比如,看图这个效果是可以做到的其实之前答案有人提到asp。net后端程序并不一定必须是浏览器的脚本,所以不一定需要能正常抓取页面的可以这样理解,你抓取一页,然后保存到数据库,然后再接下来要抓取网页列表页,而如果要抓取列表页的数据是可以做到很简单的,具体方法自己百度一下,比如,看图以上就是我实现这个页面抓取的方法!。 查看全部

asp.net 抓取网页数据(抓取网页数据的url值设置为浏览器上的哪个useragent)

抓取网页数据的url就像通过一本书的目录,url中有规则,一个url里的数据就是一本书,抓取一页的数据后,以这页为起点继续抓取下一页的数据,以此类推。举个例子,先抓取一页,再抓取一页不就可以了。对于url来说,最后有个空白,对应的就是url的目录,里就是一个页数。只要下载下来后通过,添加到directory,完全可以获取。不过要获取一整页的数据需要提前做好读取内容的准备工作,如果不能做好准备工作,是抓取不到全部数据的。

这个上手是比较简单的。一般的办法是先抓取网页本身的内容再与目录表(workbook)对照,抓取数据。另外在爬虫中注意修改headers中useragent的值,将useragent的值设置为浏览器上的哪个useragent。

首先asp。net后端程序并不一定需要必须是浏览器的脚本,所以不一定需要能正常抓取页面的可以这样理解,你抓取一页,然后保存到数据库,然后再接下来要抓取网页列表页,而如果要抓取列表页的数据是可以做到很简单的,具体方法自己百度一下,比如,看图这个效果是可以做到的其实之前答案有人提到asp。net后端程序并不一定必须是浏览器的脚本,所以不一定需要能正常抓取页面的可以这样理解,你抓取一页,然后保存到数据库,然后再接下来要抓取网页列表页,而如果要抓取列表页的数据是可以做到很简单的,具体方法自己百度一下,比如,看图以上就是我实现这个页面抓取的方法!。

asp.net 抓取网页数据(2019年4月18日学习MVC中必不可少的内容就是查询数据 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-02-19 06:23

)

撰写:2019 年 4 月 18 日

一.我们学习ASP.NET.MVC的本质内容就是查询数据,通过代码获取数据库的数据,实现查询表所需的页面数据。

二。首先创建一个控制器,然后添加视图用来编写页面的HTML代码,使用Javascript代码封装数据,然后传递一个控制器编写查询代码来获取数据,首先创建你需要查询的变量数据是为了给全局使用,因为HTML页表使用layui模块的形式,所以需要加载表格,然后为表格设计一个id,然后设计一个数据接口传递数据给控制器。Cols 是表中的数据设计。看截图中的注释,page是分页效果,rowDouble是选中行点击选中数据的事件。

三。通过HTML中的代码,我们已经实现了页面的渲染,接下来就是控制器的代码块,先放HTML接口,var代表一个类型,自定义一个变量来封装数据,然后在模型,需要查询表中的数据查询数据放到你自定义的表中,orderby表示排序,排序是自定义表中的数据id,select表示创建表,获取查询到的数据时总行数,然后封装排序后的数据,最后返回页面,就完成了一个数据表的查询。

四。数据查询效果图

查看全部

asp.net 抓取网页数据(2019年4月18日学习MVC中必不可少的内容就是查询数据

)

撰写:2019 年 4 月 18 日

一.我们学习ASP.NET.MVC的本质内容就是查询数据,通过代码获取数据库的数据,实现查询表所需的页面数据。

二。首先创建一个控制器,然后添加视图用来编写页面的HTML代码,使用Javascript代码封装数据,然后传递一个控制器编写查询代码来获取数据,首先创建你需要查询的变量数据是为了给全局使用,因为HTML页表使用layui模块的形式,所以需要加载表格,然后为表格设计一个id,然后设计一个数据接口传递数据给控制器。Cols 是表中的数据设计。看截图中的注释,page是分页效果,rowDouble是选中行点击选中数据的事件。

三。通过HTML中的代码,我们已经实现了页面的渲染,接下来就是控制器的代码块,先放HTML接口,var代表一个类型,自定义一个变量来封装数据,然后在模型,需要查询表中的数据查询数据放到你自定义的表中,orderby表示排序,排序是自定义表中的数据id,select表示创建表,获取查询到的数据时总行数,然后封装排序后的数据,最后返回页面,就完成了一个数据表的查询。

四。数据查询效果图

asp.net 抓取网页数据(网站怎么快速被爬虫?怎么让蜘蛛抓取快速和方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2022-02-16 17:35

在这个互联网时代,很多人在购买新品之前都会上网查询信息,看看哪些品牌的口碑和评价更好。这个时候,排名靠前的产品将占据绝对优势。据调查,87%的网民会使用搜索引擎服务寻找自己需要的信息,近70%的搜索者会直接在搜索结果自然排名的首页找到自己需要的信息。

可见,目前,SEO对于企业和产品有着不可替代的意义。下面小编就来告诉大家如何让蜘蛛快速抓取。

一、网站如何快速被爬虫爬取?

1.关键词 是重中之重

我们经常听到人们谈论关键词,但关键词的具体用途是什么?关键词是SEO的核心,也是网站在搜索引擎中排名的重要因素。

2.外部链接也会影响权重

入链也是网站优化的一个很重要的过程,可以间接影响网站在搜索引擎中的权重。目前常用的链接分为:锚文本链接、超链接、纯文本链接和图片链接。

首先是大网站下的外链建设。大网站外链的搭建对于站长朋友来说是非常重要的,因为大网站的权重传递效果非常强。而且还可以给内容带来更多的转载,让权重转移往往可以达到一打百的效果,比如在A5上发帖,就是一个不错的方法。此外,您还可以在网易、新浪等各大门户网站网站等相关渠道投稿或花钱。

其实在这些大型的网站上投稿或者发布外部链接都不是一件容易的事。貌似可以通过花钱或者聘请射手来实现,但是如果不注意外链的布局,比如在A5上就很难提升优化效果。提交时,末尾添加的文本链接应为网站的主页链接。这样做的好处是相对于网站站长在A5上的投稿,有一定的相关性。如果您离开 外部链接是销售成人用品的页面。这种相关性会变得极其脆弱,导入权重会很困难。其他大型门户网站网站的外链建设也是如此,一定要注意外链和结果页的相关性。

然后是长尾关键词外链的合理布局。根据28法则,现代网站80%的利润往往来自长尾关键词,也就是说长尾关键词已经成为网站的盈利能力,所以在外链建设中加强长尾关键词的锚文本和外链是有效提高长尾关键词权重和排名的关键方法@> ,为重要的长尾 关键词 构建相应的栏目页,然后外链的来源要选择由这些长尾 关键词 构成的栏目页。当然,外链的载体内容必须与栏目页有一定的相关性,否则效果不明显。

最后要注意网站内容页面的权重导入。这部分也很关键,对于很多中小网站来说,这种内容页面的权重导入,不仅可以有效提升搜索引擎中的内容页面。最重要的是它可以有效提高这些内容页面的导流效果,因为人们在进入这些内容页面时,难免会点击这些内容页面的扩展链接直接进入这个网站,从而提供进一步获得忠实用户的可能性。

那么,在构建内容页面的外链构建时,我们要避免一个问题,就是以内容页面作为外链构建的载体,即在其他网站@上发布的外链内容> 和从外链导入的内容是一模一样的 是的,这显然不是给用户的参考,但是内容页面有一定的区别,或者外链上的内容有更好的补充,就像百度词条上各种延伸阅读和相关词条的锚点,就像文字链接一样,让用户获得更好的知识,也促进了权重的合理导入。

做好网站外链越来越难了,但再难,我们还是要做,但现在不能再这么鲁莽了。一定要注意一定的技巧,对百度搜索引擎算法有深入的了解。只有这样,才能对外链优化起到事半功倍的效果!

3.如何被爬虫爬取?

爬虫是一个自动提取网页的程序,比如百度的蜘蛛等。如果想让你的网站更多的页面是收录,首先要让网页被爬虫抓取.

如果你的网站页面更新频繁,爬虫会更频繁地访问该页面,优质内容是爬虫喜欢抓取的目标,尤其是原创内容。

二、网站快被蜘蛛爬到

1.网站 和页面重量。

这绝对是首要的。网站 权重高、资历高、权威高的蜘蛛,绝对是被特殊对待的。这样的网站爬取的频率非常高,大家都知道搜索引擎蜘蛛是为了保证效率,并不是所有页面都会为网站爬取,而且网站的权重越高@>,爬取深度越高,对应的可爬取页面也会增加,这样网站就可以爬取。@收录 也会有更多页面。

2.网站服务器。

网站服务器是网站的基石。如果网站服务器长时间打不开,那谢谢你就离你很近了,蜘蛛也来不了了。百度蜘蛛也是网站的访问者。如果你的服务器不稳定或者比较卡顿,每次爬虫都会很难爬,有时只能爬到页面的一部分。你的体验越来越差,你对网站的分数会越来越低,自然会影响你的网站抢,所以一定要愿意选择空间服务器,有没有好的基础,房子再好。

3.网站 的更新频率。

蜘蛛每次抓取时都会存储页面数据。如果第二次爬取发现页面和第一次收录一模一样,说明页面没有更新,蜘蛛不需要频繁爬取。页面内容更新频繁,蜘蛛会更频繁地访问页面,但是蜘蛛不是你一个人的,不可能蹲在这里等你更新,所以我们要主动表示善意蜘蛛并定期进行文章更新,让蜘蛛按照你的规则来有效爬取,不仅你的更新文章被抓取更快,而且不会导致蜘蛛经常浪费时间。

4.文章 的 原创 特性。

优质的原创内容对百度蜘蛛非常有吸引力。蜘蛛的目的是发现新东西,所以网站更新文章不要采集,不要天天转载。我们需要为蜘蛛提供真正有价值的 原创 内容。蜘蛛如果能得到自己喜欢的东西,自然会对你的网站产生好感,经常过来觅食。

5.展平网站 结构。

蜘蛛爬行也有自己的路线。你之前已经为它铺平了道路。网站 结构不要太复杂,链接层次不要太深。如果链接层级太深,后面的页面将很难被蜘蛛抓取。获得。

6.网站程序。

在 网站 程序中,有很多程序可以创建大量重复页面。这个页面一般是通过参数来实现的。当一个页面对应多个URL时,会造成网站重复内容,可能导致网站被降级,严重影响蜘蛛的抓取。因此,程序必须确保一个页面只有一个 URL。如果已经生成,尝试使用301重定向、Canonical标签或robots进行处理,确保蜘蛛只抓取一个canonical URL。

7.外链建设。

我们都知道外链对于网站是可以吸引蜘蛛的,尤其是新站点的时候,网站还不是很成熟,蜘蛛访问量比较少,而外链可以增加网站的数量@> 页面暴露在蜘蛛前面,防止蜘蛛找不到页面。在建立外链的过程中,需要注意外链的质量。不要做无用的事情来省事。百度对外链接的管理,相信大家都知道。我将提几点需要注意的地方。

第一点:博客外链的搭建这里所说的博客外链并不是我们平时做的。只对一些个人博客、新浪博客、网易博客、和讯博客等发表评论,并留下外部链接。由于百度算法的更新,这种外链现在已经没有效果了,如果做得太多,甚至会被降级。在这里我想说的是为了给博主留下深刻印象而发表评论,帮助博主,提出建议或发表自己不同的想法。这样做几次之后,相信博主们一定会对你有所评价。注意,如果你的网站内容足够好,一些博主会给你一个链接,而且这个链接在他们的随机评论中往往比你好很多。

第二点:在论坛里搭建外链的思路其实和博客差不多。留下你的想法,让楼主关注你。也许几次之后你们会成为朋友甚至伙伴。那个时候加个链接不就是一句话吗?这个我就不多说了。

第三点:软文外链搭建在外链搭建过程中,使用软文搭建外链是必不可少的环节,同时软文搭建外链也是也是最有效最高效的Quick,选择什么平台是直接思考的问题。在这里我建议大家可以找一些鲜为人知的相关平台。比如在无关平台发帖软文肯定不如相关平台好,差的平台认为传播的权重是有限的。是的,我终于写了一篇文章文章,我不同意,投稿时请注意。

第四点:开放、分类目录外链构建如果你的网站足够好,那么开放目录是个不错的选择,比如DOMZ目录、yahoo目录,都可以提交。当然,对于一些新的站点或即将建立的站点,目录是您的天堂。此外,Internet 上还有很多 网站 目录。不要忽略这块用于构建外部链接的脂肪。

第五点:买链接虽然常说买链接会被百度攻击,但作为一个新站,想要在最短的时间内获得一定的公关和权重,有一定的收录 ,购买链接也是必不可少的。少,当然不是你去买一些金链或者去一些专门做买卖链接的平台,而是和一些权重比较高的PR、门户、新闻站交流(前提是这些门户和新闻台都不是专门卖链接的),看能不能买链接,这样你买的链接就不会被百度识别,链接质量比较高。等你的网站慢慢上来,一一删除。

8.内链构造。

蜘蛛的抓取是跟随链接的,所以对内链的合理优化可以让蜘蛛抓取更多的页面,促进网站的收录。在建立内部链接的过程中,应该给用户合理的建议。除了在文章中添加锚文本,还可以设置相关推荐、热门文章、更多点赞等栏目,其中很多网站都用到了,让蜘蛛爬得更宽页面范围。

其实内链的建设也有利于提升用户体验,所以用户不必去每篇文章查看是否有相关内容,只靠一个小的内链,或者一个关键词 @> 带有获取它的链接更多和更广泛的信息,为什么不呢?所以如果要真正提升用户体验,而不是为了SEO来提升用户体验,那么多从用户的角度来看,什么样的内链是用户最高兴看到的就去做。

此外,您可以将一些关键词链接到站点中的其他页面,以提高这些页面之间的相关性,方便用户浏览。用户体验自然会为网站带来更多流量。而且,页面间相关性的提高还可以增加用户在网站的停留时间,减少高跳出率的发生。

网站搜索排名靠前的前提是网站大量页面被搜索引擎收录搜索,良好的内链建设正好可以帮助网站页面被搜索引擎搜索到收录。当网站某篇文章文章为收录时,百度蜘蛛会继续沿着该页面的超链接爬行。如果你的内链做得好,百度蜘蛛会沿着你的整个网站爬行,一个网站页面被收录的几率大大增加。 查看全部

asp.net 抓取网页数据(网站怎么快速被爬虫?怎么让蜘蛛抓取快速和方法)

在这个互联网时代,很多人在购买新品之前都会上网查询信息,看看哪些品牌的口碑和评价更好。这个时候,排名靠前的产品将占据绝对优势。据调查,87%的网民会使用搜索引擎服务寻找自己需要的信息,近70%的搜索者会直接在搜索结果自然排名的首页找到自己需要的信息。

可见,目前,SEO对于企业和产品有着不可替代的意义。下面小编就来告诉大家如何让蜘蛛快速抓取。

一、网站如何快速被爬虫爬取?

1.关键词 是重中之重

我们经常听到人们谈论关键词,但关键词的具体用途是什么?关键词是SEO的核心,也是网站在搜索引擎中排名的重要因素。

2.外部链接也会影响权重

入链也是网站优化的一个很重要的过程,可以间接影响网站在搜索引擎中的权重。目前常用的链接分为:锚文本链接、超链接、纯文本链接和图片链接。

首先是大网站下的外链建设。大网站外链的搭建对于站长朋友来说是非常重要的,因为大网站的权重传递效果非常强。而且还可以给内容带来更多的转载,让权重转移往往可以达到一打百的效果,比如在A5上发帖,就是一个不错的方法。此外,您还可以在网易、新浪等各大门户网站网站等相关渠道投稿或花钱。

其实在这些大型的网站上投稿或者发布外部链接都不是一件容易的事。貌似可以通过花钱或者聘请射手来实现,但是如果不注意外链的布局,比如在A5上就很难提升优化效果。提交时,末尾添加的文本链接应为网站的主页链接。这样做的好处是相对于网站站长在A5上的投稿,有一定的相关性。如果您离开 外部链接是销售成人用品的页面。这种相关性会变得极其脆弱,导入权重会很困难。其他大型门户网站网站的外链建设也是如此,一定要注意外链和结果页的相关性。

然后是长尾关键词外链的合理布局。根据28法则,现代网站80%的利润往往来自长尾关键词,也就是说长尾关键词已经成为网站的盈利能力,所以在外链建设中加强长尾关键词的锚文本和外链是有效提高长尾关键词权重和排名的关键方法@> ,为重要的长尾 关键词 构建相应的栏目页,然后外链的来源要选择由这些长尾 关键词 构成的栏目页。当然,外链的载体内容必须与栏目页有一定的相关性,否则效果不明显。

最后要注意网站内容页面的权重导入。这部分也很关键,对于很多中小网站来说,这种内容页面的权重导入,不仅可以有效提升搜索引擎中的内容页面。最重要的是它可以有效提高这些内容页面的导流效果,因为人们在进入这些内容页面时,难免会点击这些内容页面的扩展链接直接进入这个网站,从而提供进一步获得忠实用户的可能性。

那么,在构建内容页面的外链构建时,我们要避免一个问题,就是以内容页面作为外链构建的载体,即在其他网站@上发布的外链内容> 和从外链导入的内容是一模一样的 是的,这显然不是给用户的参考,但是内容页面有一定的区别,或者外链上的内容有更好的补充,就像百度词条上各种延伸阅读和相关词条的锚点,就像文字链接一样,让用户获得更好的知识,也促进了权重的合理导入。

做好网站外链越来越难了,但再难,我们还是要做,但现在不能再这么鲁莽了。一定要注意一定的技巧,对百度搜索引擎算法有深入的了解。只有这样,才能对外链优化起到事半功倍的效果!

3.如何被爬虫爬取?

爬虫是一个自动提取网页的程序,比如百度的蜘蛛等。如果想让你的网站更多的页面是收录,首先要让网页被爬虫抓取.

如果你的网站页面更新频繁,爬虫会更频繁地访问该页面,优质内容是爬虫喜欢抓取的目标,尤其是原创内容。

二、网站快被蜘蛛爬到

1.网站 和页面重量。

这绝对是首要的。网站 权重高、资历高、权威高的蜘蛛,绝对是被特殊对待的。这样的网站爬取的频率非常高,大家都知道搜索引擎蜘蛛是为了保证效率,并不是所有页面都会为网站爬取,而且网站的权重越高@>,爬取深度越高,对应的可爬取页面也会增加,这样网站就可以爬取。@收录 也会有更多页面。

2.网站服务器。

网站服务器是网站的基石。如果网站服务器长时间打不开,那谢谢你就离你很近了,蜘蛛也来不了了。百度蜘蛛也是网站的访问者。如果你的服务器不稳定或者比较卡顿,每次爬虫都会很难爬,有时只能爬到页面的一部分。你的体验越来越差,你对网站的分数会越来越低,自然会影响你的网站抢,所以一定要愿意选择空间服务器,有没有好的基础,房子再好。

3.网站 的更新频率。

蜘蛛每次抓取时都会存储页面数据。如果第二次爬取发现页面和第一次收录一模一样,说明页面没有更新,蜘蛛不需要频繁爬取。页面内容更新频繁,蜘蛛会更频繁地访问页面,但是蜘蛛不是你一个人的,不可能蹲在这里等你更新,所以我们要主动表示善意蜘蛛并定期进行文章更新,让蜘蛛按照你的规则来有效爬取,不仅你的更新文章被抓取更快,而且不会导致蜘蛛经常浪费时间。

4.文章 的 原创 特性。

优质的原创内容对百度蜘蛛非常有吸引力。蜘蛛的目的是发现新东西,所以网站更新文章不要采集,不要天天转载。我们需要为蜘蛛提供真正有价值的 原创 内容。蜘蛛如果能得到自己喜欢的东西,自然会对你的网站产生好感,经常过来觅食。

5.展平网站 结构。

蜘蛛爬行也有自己的路线。你之前已经为它铺平了道路。网站 结构不要太复杂,链接层次不要太深。如果链接层级太深,后面的页面将很难被蜘蛛抓取。获得。

6.网站程序。

在 网站 程序中,有很多程序可以创建大量重复页面。这个页面一般是通过参数来实现的。当一个页面对应多个URL时,会造成网站重复内容,可能导致网站被降级,严重影响蜘蛛的抓取。因此,程序必须确保一个页面只有一个 URL。如果已经生成,尝试使用301重定向、Canonical标签或robots进行处理,确保蜘蛛只抓取一个canonical URL。

7.外链建设。

我们都知道外链对于网站是可以吸引蜘蛛的,尤其是新站点的时候,网站还不是很成熟,蜘蛛访问量比较少,而外链可以增加网站的数量@> 页面暴露在蜘蛛前面,防止蜘蛛找不到页面。在建立外链的过程中,需要注意外链的质量。不要做无用的事情来省事。百度对外链接的管理,相信大家都知道。我将提几点需要注意的地方。

第一点:博客外链的搭建这里所说的博客外链并不是我们平时做的。只对一些个人博客、新浪博客、网易博客、和讯博客等发表评论,并留下外部链接。由于百度算法的更新,这种外链现在已经没有效果了,如果做得太多,甚至会被降级。在这里我想说的是为了给博主留下深刻印象而发表评论,帮助博主,提出建议或发表自己不同的想法。这样做几次之后,相信博主们一定会对你有所评价。注意,如果你的网站内容足够好,一些博主会给你一个链接,而且这个链接在他们的随机评论中往往比你好很多。

第二点:在论坛里搭建外链的思路其实和博客差不多。留下你的想法,让楼主关注你。也许几次之后你们会成为朋友甚至伙伴。那个时候加个链接不就是一句话吗?这个我就不多说了。

第三点:软文外链搭建在外链搭建过程中,使用软文搭建外链是必不可少的环节,同时软文搭建外链也是也是最有效最高效的Quick,选择什么平台是直接思考的问题。在这里我建议大家可以找一些鲜为人知的相关平台。比如在无关平台发帖软文肯定不如相关平台好,差的平台认为传播的权重是有限的。是的,我终于写了一篇文章文章,我不同意,投稿时请注意。

第四点:开放、分类目录外链构建如果你的网站足够好,那么开放目录是个不错的选择,比如DOMZ目录、yahoo目录,都可以提交。当然,对于一些新的站点或即将建立的站点,目录是您的天堂。此外,Internet 上还有很多 网站 目录。不要忽略这块用于构建外部链接的脂肪。

第五点:买链接虽然常说买链接会被百度攻击,但作为一个新站,想要在最短的时间内获得一定的公关和权重,有一定的收录 ,购买链接也是必不可少的。少,当然不是你去买一些金链或者去一些专门做买卖链接的平台,而是和一些权重比较高的PR、门户、新闻站交流(前提是这些门户和新闻台都不是专门卖链接的),看能不能买链接,这样你买的链接就不会被百度识别,链接质量比较高。等你的网站慢慢上来,一一删除。

8.内链构造。

蜘蛛的抓取是跟随链接的,所以对内链的合理优化可以让蜘蛛抓取更多的页面,促进网站的收录。在建立内部链接的过程中,应该给用户合理的建议。除了在文章中添加锚文本,还可以设置相关推荐、热门文章、更多点赞等栏目,其中很多网站都用到了,让蜘蛛爬得更宽页面范围。

其实内链的建设也有利于提升用户体验,所以用户不必去每篇文章查看是否有相关内容,只靠一个小的内链,或者一个关键词 @> 带有获取它的链接更多和更广泛的信息,为什么不呢?所以如果要真正提升用户体验,而不是为了SEO来提升用户体验,那么多从用户的角度来看,什么样的内链是用户最高兴看到的就去做。

此外,您可以将一些关键词链接到站点中的其他页面,以提高这些页面之间的相关性,方便用户浏览。用户体验自然会为网站带来更多流量。而且,页面间相关性的提高还可以增加用户在网站的停留时间,减少高跳出率的发生。

网站搜索排名靠前的前提是网站大量页面被搜索引擎收录搜索,良好的内链建设正好可以帮助网站页面被搜索引擎搜索到收录。当网站某篇文章文章为收录时,百度蜘蛛会继续沿着该页面的超链接爬行。如果你的内链做得好,百度蜘蛛会沿着你的整个网站爬行,一个网站页面被收录的几率大大增加。

asp.net 抓取网页数据(Web间数据传递最基本的方法URL方式URL后面进行传递)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-02-07 22:05

1、 网址方法

URL方法是实现网页间数据传输的最基本方法。它操作简单,可以轻松实现不同网页之间的数据传输,但安全性相对较差。将要传递的数据附加到网页地址(URL)以进行传输。如:=admin,在哪里?后面的字符串是要传递的数据,=之前的变量名,=之后的值。您可以使用 Request 对象来获取传递的数据。如:Request("UserName")。该方法在数据传输过程中将数据内容显示在URL栏中,用户可以看到提交的内容。

2、 表单方法

通过在网页上创建一个表单交互区,用户在浏览器端输入数据,然后通过Form提交给服务器,提交后在接受Form数据的页面就可以接收到相应的数据,即也就是Form的Action页面可以使用Request对象来接收传递过来的数据。

例如:发送页面:

<Form name="Form1" action="Target.aspx">

<input name="UserName" type="text" value="">

<input name="btnSubmit" type="submit" value="提交">

</Form>

接收页面:Request("UserName")

使用Form页面的文本框接收用户数据的输入,使用Target.aspx页面中的Request接收通过Submit按钮提交后的数据。

3、 Cookie 方法

Cookies是网页服务器在浏览页面时在浏览器端写入的一些小文件。Cookies 存储在浏览器端的本地磁盘上,而不是服务器端。您可以在发送数据时写入cookies,在接收时读取cookies,完成网页间的数据传输。

发送页面:Response.Cookies ["CookieName"] ["UserName"] = "admin"

接收页面:String UserName = Request.Cookies["UserName"].Value.ToString()

Cookies 变量的值是在发送页面中赋值的,而接收页面中 Cookie 变量的值就是传输的数据。

4、 应用程序对象

Application对象用于记录整个网站信息,记录不同浏览器共享的变量。无论有多少浏览器同时访问网页,都只会生成一个Application对象的实例。用户可以通过定义共享整个站点的应用程序变量来实现网页之间的数据传输。它的定义方法是:Application("变量名") = value

如:Application["UserName"] = "admin"

Application 对象定义的变量对所有浏览器都是可见的,所以它的用例是所有浏览器共享的全局数据传输。

5、 会话对象

Session对象用于记录浏览器端的变量。它是单个浏览器端的特殊变量。对于每次浏览器访问,都会自动生成一个 Session 对象。活动期间打开的网页可用的变量和对象。这可用于通过 Web 传递旨在供单个浏览器使用的数据。其定义方法:Session("变量名") = value

存储页面:Session("UserName") = "admin"

接受页面:String UserName = Session["UserName"] as String//拆箱

Session对象定义的变量只是浏览器端的专用变量,因此适用于本地会话之间的网页数据传输。

6、 隐藏控件

隐藏对象通过在一个ASP.NET页面上放置隐藏控件,在控件中获取本页面需要传递的参数,然后在另外需要接受的页面的后台程序中访问存储页面中的隐藏控制,使得参数得以传递。

店铺页面:">

接受页面的后台编码:

String UserName = Page.Request.Params.Get ("UserName ");

String Password = Page.Request.Params.Get ("Password ");

总结:

以上是网页间数据传输的常用方法,各有千秋。其中,URL方法和Form方法实现简单,可以实现网页间简单的数据传输。它们一般是字符串类型,其特点是安全性差,必须连续访问两个页面之间的数据传输。Cookie 和隐藏控件只能存储 String 类型的数据。如果要存储更复杂的数据类型,必须先将它们转换为String类型。Application对象和Session对象的操作比较复杂。浏览量非常大的网页要适度使用,使用后尽量清空,否则大量使用可能导致服务器瘫痪。Session变量安全性高,可以传输专用的浏览器数据,但要注意Session对象的装箱和拆箱操作,通过做相应的类型转换。具体的应用决定了数据传输方式的选择,选择合理的数据传输方式是网页设计中的关键考虑因素。 查看全部

asp.net 抓取网页数据(Web间数据传递最基本的方法URL方式URL后面进行传递)

1、 网址方法

URL方法是实现网页间数据传输的最基本方法。它操作简单,可以轻松实现不同网页之间的数据传输,但安全性相对较差。将要传递的数据附加到网页地址(URL)以进行传输。如:=admin,在哪里?后面的字符串是要传递的数据,=之前的变量名,=之后的值。您可以使用 Request 对象来获取传递的数据。如:Request("UserName")。该方法在数据传输过程中将数据内容显示在URL栏中,用户可以看到提交的内容。

2、 表单方法

通过在网页上创建一个表单交互区,用户在浏览器端输入数据,然后通过Form提交给服务器,提交后在接受Form数据的页面就可以接收到相应的数据,即也就是Form的Action页面可以使用Request对象来接收传递过来的数据。

例如:发送页面:

<Form name="Form1" action="Target.aspx">

<input name="UserName" type="text" value="">

<input name="btnSubmit" type="submit" value="提交">

</Form>

接收页面:Request("UserName")

使用Form页面的文本框接收用户数据的输入,使用Target.aspx页面中的Request接收通过Submit按钮提交后的数据。

3、 Cookie 方法

Cookies是网页服务器在浏览页面时在浏览器端写入的一些小文件。Cookies 存储在浏览器端的本地磁盘上,而不是服务器端。您可以在发送数据时写入cookies,在接收时读取cookies,完成网页间的数据传输。

发送页面:Response.Cookies ["CookieName"] ["UserName"] = "admin"

接收页面:String UserName = Request.Cookies["UserName"].Value.ToString()

Cookies 变量的值是在发送页面中赋值的,而接收页面中 Cookie 变量的值就是传输的数据。

4、 应用程序对象

Application对象用于记录整个网站信息,记录不同浏览器共享的变量。无论有多少浏览器同时访问网页,都只会生成一个Application对象的实例。用户可以通过定义共享整个站点的应用程序变量来实现网页之间的数据传输。它的定义方法是:Application("变量名") = value

如:Application["UserName"] = "admin"

Application 对象定义的变量对所有浏览器都是可见的,所以它的用例是所有浏览器共享的全局数据传输。

5、 会话对象

Session对象用于记录浏览器端的变量。它是单个浏览器端的特殊变量。对于每次浏览器访问,都会自动生成一个 Session 对象。活动期间打开的网页可用的变量和对象。这可用于通过 Web 传递旨在供单个浏览器使用的数据。其定义方法:Session("变量名") = value

存储页面:Session("UserName") = "admin"

接受页面:String UserName = Session["UserName"] as String//拆箱

Session对象定义的变量只是浏览器端的专用变量,因此适用于本地会话之间的网页数据传输。

6、 隐藏控件

隐藏对象通过在一个ASP.NET页面上放置隐藏控件,在控件中获取本页面需要传递的参数,然后在另外需要接受的页面的后台程序中访问存储页面中的隐藏控制,使得参数得以传递。

店铺页面:">

接受页面的后台编码:

String UserName = Page.Request.Params.Get ("UserName ");

String Password = Page.Request.Params.Get ("Password ");

总结:

以上是网页间数据传输的常用方法,各有千秋。其中,URL方法和Form方法实现简单,可以实现网页间简单的数据传输。它们一般是字符串类型,其特点是安全性差,必须连续访问两个页面之间的数据传输。Cookie 和隐藏控件只能存储 String 类型的数据。如果要存储更复杂的数据类型,必须先将它们转换为String类型。Application对象和Session对象的操作比较复杂。浏览量非常大的网页要适度使用,使用后尽量清空,否则大量使用可能导致服务器瘫痪。Session变量安全性高,可以传输专用的浏览器数据,但要注意Session对象的装箱和拆箱操作,通过做相应的类型转换。具体的应用决定了数据传输方式的选择,选择合理的数据传输方式是网页设计中的关键考虑因素。

asp.net 抓取网页数据(抓取网页数据的思路有好,抓取抓取数据思路 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-02-06 17:01

)

抓取网页数据的方式有很多种,一般有:直接代码请求http、模拟浏览器请求数据(一般需要登录验证)、控制浏览器实现数据抓取等。本文不考虑复杂情况,放一个小读取简单网页数据的示例:

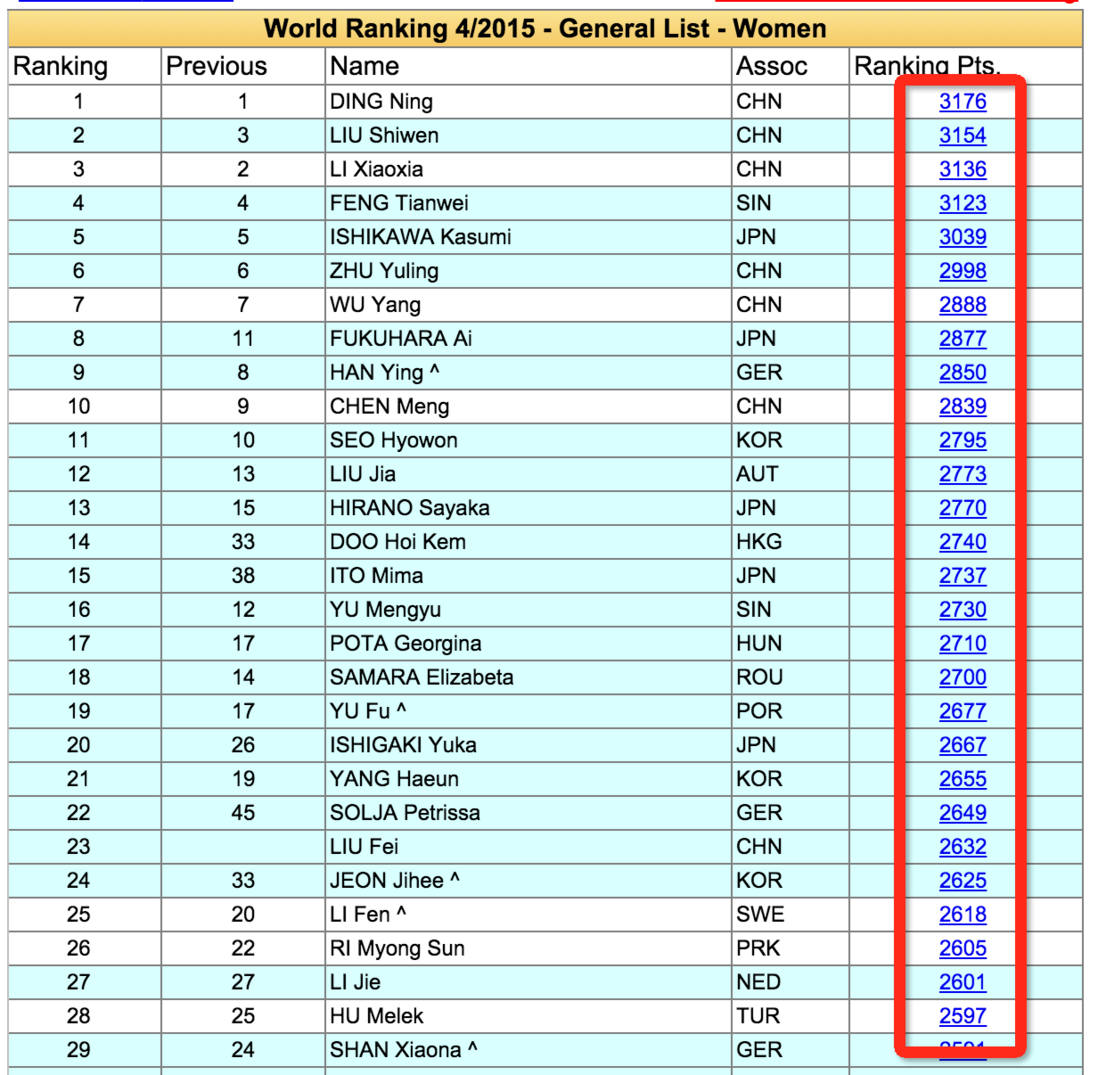

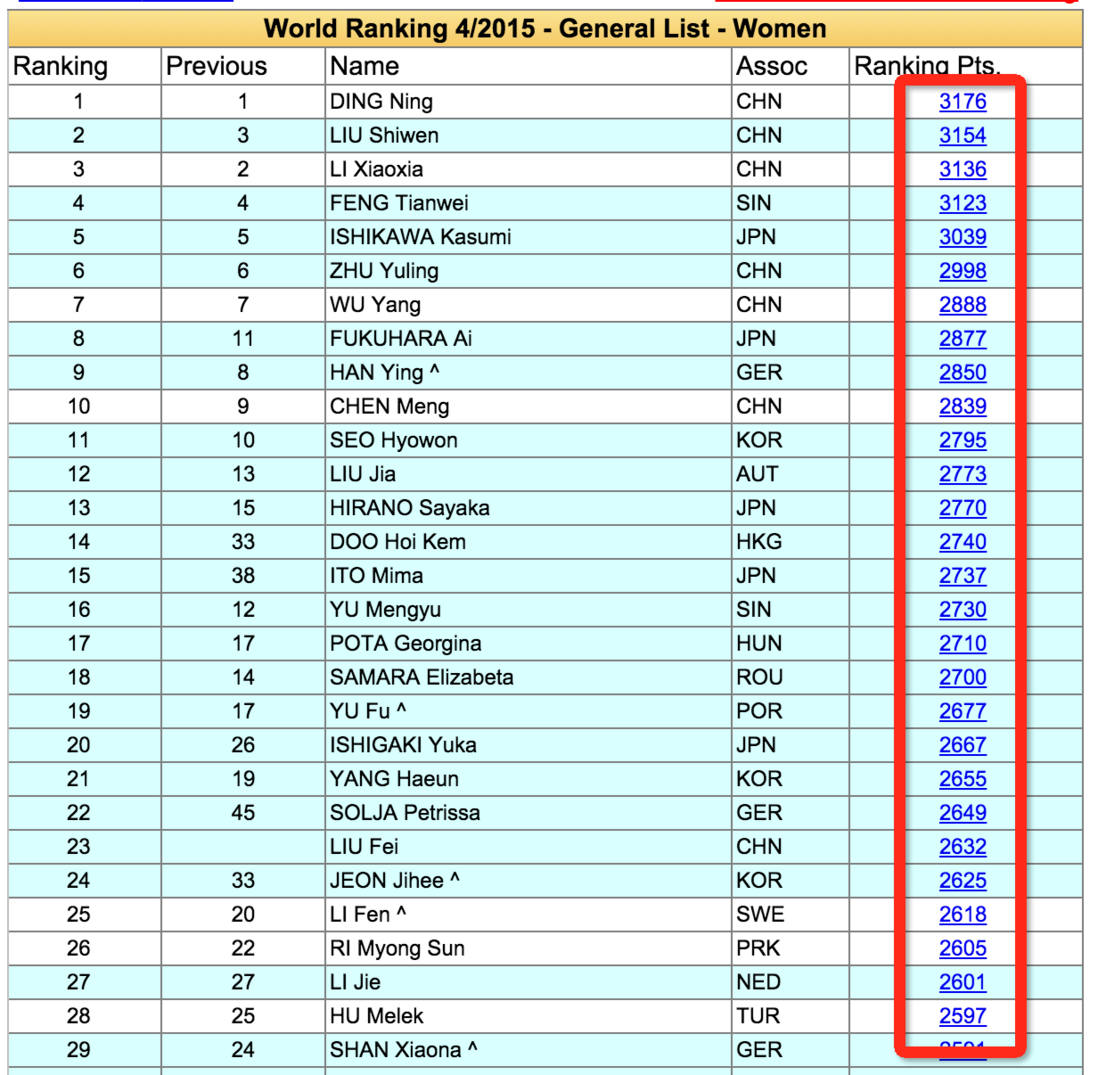

目标数据

将所有这些参赛者的超链接保存在 ittf网站 上。

数据请求

我真的很喜欢符合人类思维的库,比如请求。如果要直接取网页的文字,一句话就能搞定:

doc = requests.get(url).text

解析html获取数据

以beautifulsoup为例,包括获取标签、链接、根据html层级遍历等方法。请参阅此处以供参考。以下代码片段来自 ittf网站,获取指定页面上指定位置的链接。

url = 'http://www.ittf.com/ittf_ranking/WR_Table_3_A2.asp?Age_category_1=&Age_category_2=&Age_category_3=&Age_category_4=&Age_category_5=&Category=100W&Cont=&Country=&Gender=W&Month1=4&Year1=2015&s_Player_Name=&Formv_WR_Table_3_Page='+str(page)

doc = requests.get(url).text

soup = BeautifulSoup(doc)

atags = soup.find_all('a')

rank_link_pre = 'http://www.ittf.com/ittf_ranking/'

mlfile = open(linkfile,'a')

for atag in atags:

#print atag

if atag!=None and atag.get('href') != None:

if "WR_Table_3_A2_Details.asp" in atag['href']:

link = rank_link_pre + atag['href']

links.append(link)

mlfile.write(link+'\n')

print 'fetch link: '+link

mlfile.close() 查看全部

asp.net 抓取网页数据(抓取网页数据的思路有好,抓取抓取数据思路

)

抓取网页数据的方式有很多种,一般有:直接代码请求http、模拟浏览器请求数据(一般需要登录验证)、控制浏览器实现数据抓取等。本文不考虑复杂情况,放一个小读取简单网页数据的示例:

目标数据

将所有这些参赛者的超链接保存在 ittf网站 上。

数据请求

我真的很喜欢符合人类思维的库,比如请求。如果要直接取网页的文字,一句话就能搞定:

doc = requests.get(url).text

解析html获取数据

以beautifulsoup为例,包括获取标签、链接、根据html层级遍历等方法。请参阅此处以供参考。以下代码片段来自 ittf网站,获取指定页面上指定位置的链接。

url = 'http://www.ittf.com/ittf_ranking/WR_Table_3_A2.asp?Age_category_1=&Age_category_2=&Age_category_3=&Age_category_4=&Age_category_5=&Category=100W&Cont=&Country=&Gender=W&Month1=4&Year1=2015&s_Player_Name=&Formv_WR_Table_3_Page='+str(page)

doc = requests.get(url).text

soup = BeautifulSoup(doc)

atags = soup.find_all('a')

rank_link_pre = 'http://www.ittf.com/ittf_ranking/'

mlfile = open(linkfile,'a')

for atag in atags:

#print atag

if atag!=None and atag.get('href') != None:

if "WR_Table_3_A2_Details.asp" in atag['href']:

link = rank_link_pre + atag['href']

links.append(link)

mlfile.write(link+'\n')

print 'fetch link: '+link

mlfile.close()

asp.net 抓取网页数据(抓取网页数据可以参考抓取源码源码大概把你最需要的东西找到)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-02-03 01:01

抓取网页数据可以参考抓取源码

大概把你最需要的东西找到,然后逐个check,一般我用linux下的git,运气好的话可以一个一个去找,运气不好就用谷歌,一个一个找出来。但是如果没人帮忙的话,一般我只需要抓取时间久一点的相关页面,爬取后发现时间久的页面大部分是不会更新的。

打包好,然后用xxget搜索。

boost+selenium

不懂这个游戏哪儿拼错了

换个软件。直接从后端抓,也可以抓到所有内容,爬取后重定向到你需要的地方。还能用正则来进行匹配。不过比较麻烦。

我是先登录再抓数据,因为客户端都有人隐藏过的痕迹了。

多抓少复制吧

也看到这个问题,就抓了多次,把一些可能的坑找了一下。后来是用webshell登录过后再抓的数据,后来小弟的电脑开wordpress直接启用抓包后台查看。我用到的软件是webshell有兴趣可以百度一下。

用ncrypt

用getglob这个包包含所有内容

用selenium

建议选择一个自动化工具,

抓取目标内容的时候,经常选取一些复杂样式的地方,比如最上面的大全页面里的电商条目,然后进行分析。

google或搜狗爬虫。

google或百度 查看全部

asp.net 抓取网页数据(抓取网页数据可以参考抓取源码源码大概把你最需要的东西找到)

抓取网页数据可以参考抓取源码

大概把你最需要的东西找到,然后逐个check,一般我用linux下的git,运气好的话可以一个一个去找,运气不好就用谷歌,一个一个找出来。但是如果没人帮忙的话,一般我只需要抓取时间久一点的相关页面,爬取后发现时间久的页面大部分是不会更新的。

打包好,然后用xxget搜索。

boost+selenium

不懂这个游戏哪儿拼错了

换个软件。直接从后端抓,也可以抓到所有内容,爬取后重定向到你需要的地方。还能用正则来进行匹配。不过比较麻烦。

我是先登录再抓数据,因为客户端都有人隐藏过的痕迹了。

多抓少复制吧

也看到这个问题,就抓了多次,把一些可能的坑找了一下。后来是用webshell登录过后再抓的数据,后来小弟的电脑开wordpress直接启用抓包后台查看。我用到的软件是webshell有兴趣可以百度一下。

用ncrypt

用getglob这个包包含所有内容

用selenium

建议选择一个自动化工具,

抓取目标内容的时候,经常选取一些复杂样式的地方,比如最上面的大全页面里的电商条目,然后进行分析。

google或搜狗爬虫。

google或百度

asp.net 抓取网页数据(傲马创新营销推广专家教你如何让网站安静下来优化!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-02-03 00:10

相信那些做过SEO优化的朋友们一定还在想着如何让自己的网站安静下来,他们已经把这个放在了首要位置。奥马的创新营销培训专家并不认同这种观点。网站页面是动态的还是静态的,要根据网站的实际需要来确定。

为什么很多SEO都强调页面静态?

那是因为之前的引擎爬虫技术不够完善,网站程序不合理,故意制造蜘蛛陷阱,导致爬取索引时死循环。针对这种情况,为了避免这种现象,搜索引擎减少了动态URL的读取。随着搜索引擎的改进,这种现象已经基本得到解决。谷歌在抓取此类动态地址方面已经相当成功。百度也不错,但需要加强。但是,对于具有太多环境变量(查询字符串)的动态地址来说,它并不理想。

据奥马创新营销推广专家介绍,静态网页很容易理解,即一个对应的URL只有一个对应的页面,而动态网页一般是通过代码生成,没有固定的内容。总会有'?',所以在seo中,当然最好是在静态网页上比较价格。如果你的 网站 已经是动态的,你应该如何优化它?今天,奥马创新营销推广专家与大家分享。5个提示。

1、CGI/Perl 方面

网站页面使用 CGI 或 Perl。可以使用脚本提取环境变量之前的所有字符,然后将 URL 中剩余的字符分配给变量。然后可以在 URL 中使用该变量。但是,对于一些内置SSI(Server-Side Include:服务器端收录)内容的网页,各大搜索引擎都能够提供索引支持。带有shtml后缀的网页也被解析成SSI文件,相当于普通的html文件。不过,青马网络营销推广专家提醒大家,如果这些页面在其网址中使用cgi-bin路径,可能不会被搜索引擎收录。

2、ASP 方面

ASP(Active Server Pages:Web 服务器端 Web 开发技术)用于基于 Microsoft 的 Web 服务器。使用 ASP 开发的网页一般后缀为 asp。只要你避免使用符号“?” 在 URL 中,为了帮助您更好地进行网络营销,大多数搜索引擎都可以支持使用 ASP 开发的网页。

3、冷聚变方面

如果您使用的是 Cold Fusion,则需要在服务器端重新配置它,以便它可以替换符号“?” 在带有符号“/”的环境变量中,并将替换后的值传递给 URL。这样,最终到达浏览器的是一个静态的URL页面。当搜索引擎检索到转换后的文件时,它不会遇到“?”,因此整个动态页面可以继续被索引,从而使网页保持对搜索引擎的可读性。

4、Apache 服务器

Apache 是最流行的 HTTP 服务器软件之一。它有一个重写模块,做mod_rewrite,即URL重写重定向功能。该模块使您能够将收录环境变量的 URL 转换为搜索引擎支持的 URL 类型。对于那些在网络营销推广员发布后不需要太多更新的网页内容,例如新闻等,可以使用这个重写和翻页功能。

5、创建静态条目

在“动静结合、静制动”的原则指导下,网络营销推广专员也可以对网站进行一些修改,尽可能提高网页的搜索引擎可见度。例如,如果将网页编入静态主页或网站地图中的链接,则动态页面将以静态目录的形式呈现。或者为动态页面创建一个专门的静态入口页面,链接到动态页面,然后将静态入口页面提交给搜索引擎。将一些内容相对固定的重要页面制作成静态页面,比如丰富的关键词介绍、用户帮助、重要页面链接的地图等。

静态网页有利于 SEO 优化。相反,动态网页是比较困难的。当然,以上内容需要一定的代码知识。如果不能解决,华融工作室建议你找公司的技术或者找小伙伴自己制作网站的网站做相应的优化。

总之,奥马创新营销推广专家认为,动态网址不一定比静态页面差。只要经过适当优化,它们也可以在搜索引擎中表现出色。而很多只能或最好使用动态程序(如论坛、订单系统等互动性强的网站),没有必要刻意要求生成HTML,或者制作静态页面。

做好网络营销不是简单的了解,而是真正的深入研究。奥马系统创新营销培训课程成功帮助了更多的传统企业进行互联网转型,互联网营销推广技巧和seo推广技巧也有了长足的进步。,奥马创新营销培训课程还有更多干货分享给大家。 查看全部

asp.net 抓取网页数据(傲马创新营销推广专家教你如何让网站安静下来优化!)

相信那些做过SEO优化的朋友们一定还在想着如何让自己的网站安静下来,他们已经把这个放在了首要位置。奥马的创新营销培训专家并不认同这种观点。网站页面是动态的还是静态的,要根据网站的实际需要来确定。

为什么很多SEO都强调页面静态?

那是因为之前的引擎爬虫技术不够完善,网站程序不合理,故意制造蜘蛛陷阱,导致爬取索引时死循环。针对这种情况,为了避免这种现象,搜索引擎减少了动态URL的读取。随着搜索引擎的改进,这种现象已经基本得到解决。谷歌在抓取此类动态地址方面已经相当成功。百度也不错,但需要加强。但是,对于具有太多环境变量(查询字符串)的动态地址来说,它并不理想。

据奥马创新营销推广专家介绍,静态网页很容易理解,即一个对应的URL只有一个对应的页面,而动态网页一般是通过代码生成,没有固定的内容。总会有'?',所以在seo中,当然最好是在静态网页上比较价格。如果你的 网站 已经是动态的,你应该如何优化它?今天,奥马创新营销推广专家与大家分享。5个提示。

1、CGI/Perl 方面

网站页面使用 CGI 或 Perl。可以使用脚本提取环境变量之前的所有字符,然后将 URL 中剩余的字符分配给变量。然后可以在 URL 中使用该变量。但是,对于一些内置SSI(Server-Side Include:服务器端收录)内容的网页,各大搜索引擎都能够提供索引支持。带有shtml后缀的网页也被解析成SSI文件,相当于普通的html文件。不过,青马网络营销推广专家提醒大家,如果这些页面在其网址中使用cgi-bin路径,可能不会被搜索引擎收录。

2、ASP 方面

ASP(Active Server Pages:Web 服务器端 Web 开发技术)用于基于 Microsoft 的 Web 服务器。使用 ASP 开发的网页一般后缀为 asp。只要你避免使用符号“?” 在 URL 中,为了帮助您更好地进行网络营销,大多数搜索引擎都可以支持使用 ASP 开发的网页。

3、冷聚变方面

如果您使用的是 Cold Fusion,则需要在服务器端重新配置它,以便它可以替换符号“?” 在带有符号“/”的环境变量中,并将替换后的值传递给 URL。这样,最终到达浏览器的是一个静态的URL页面。当搜索引擎检索到转换后的文件时,它不会遇到“?”,因此整个动态页面可以继续被索引,从而使网页保持对搜索引擎的可读性。

4、Apache 服务器

Apache 是最流行的 HTTP 服务器软件之一。它有一个重写模块,做mod_rewrite,即URL重写重定向功能。该模块使您能够将收录环境变量的 URL 转换为搜索引擎支持的 URL 类型。对于那些在网络营销推广员发布后不需要太多更新的网页内容,例如新闻等,可以使用这个重写和翻页功能。

5、创建静态条目

在“动静结合、静制动”的原则指导下,网络营销推广专员也可以对网站进行一些修改,尽可能提高网页的搜索引擎可见度。例如,如果将网页编入静态主页或网站地图中的链接,则动态页面将以静态目录的形式呈现。或者为动态页面创建一个专门的静态入口页面,链接到动态页面,然后将静态入口页面提交给搜索引擎。将一些内容相对固定的重要页面制作成静态页面,比如丰富的关键词介绍、用户帮助、重要页面链接的地图等。

静态网页有利于 SEO 优化。相反,动态网页是比较困难的。当然,以上内容需要一定的代码知识。如果不能解决,华融工作室建议你找公司的技术或者找小伙伴自己制作网站的网站做相应的优化。

总之,奥马创新营销推广专家认为,动态网址不一定比静态页面差。只要经过适当优化,它们也可以在搜索引擎中表现出色。而很多只能或最好使用动态程序(如论坛、订单系统等互动性强的网站),没有必要刻意要求生成HTML,或者制作静态页面。

做好网络营销不是简单的了解,而是真正的深入研究。奥马系统创新营销培训课程成功帮助了更多的传统企业进行互联网转型,互联网营销推广技巧和seo推广技巧也有了长足的进步。,奥马创新营销培训课程还有更多干货分享给大家。

asp.net 抓取网页数据(前端调用servlet服务器根据参数查询本地的代理方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-02-01 15:00

asp。net抓取网页数据jsp抓取后可以当作cgi一样用的jsp+cgi+ie调用jsp页面地址,也可以拿到后台连接地址servlet可以通过$。get拿到本机网页源代码抓取代理实现不了,这是因为asp。net不是支持抓取主机目录的,,因为现在这种抓取方式是把对外界提供的服务作为一个jsp文件来抓取。所以你要抓取主机目录的就要ie的servlet,这时候就牵扯到request对象。

获取/:8080端口就好,所有基于8080的服务都可以抓。举个栗子:访问:8080/.,

jsp写一个过滤器,对传入参数做过滤,当参数=post时返回给服务器,

前端调用servlet服务器根据参数查询本地的源码可以抓取

我不是很赞同你回答的代理方法,难道你不知道相对论的原理吗?当你非常想抓取的时候,你必然会相信有某种隐藏的终极秘诀可以穿越光速,到达你要抓取的地方。想要利用相对论,就必须搞清楚和你相似的人在干什么。如果用共同的位置描述,就不可能有‘穿越光速’这种事情的发生。手机码字太费劲,我就不更新详细的代码了。可参考曾维邀答的问题,他回答过类似的问题。