资讯内容采集系统

资讯内容采集系统(资讯内容采集系统的前途一片大好前景如何?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2022-04-07 21:05

资讯内容采集系统采用先进的saas模式运营,完全地采用云端管理模式。集人工智能、大数据、机器学习、语音识别、ai、ai算法、软件开发、语音合成、人工智能的系统开发、教育技术的系统开发等于一体的大型服务平台。包括所有内容采集信息网站、公众号信息、官网信息、学校招生信息、学校招生专业库、教育局政策性文件、教育培训机构全国招生信息、新鲜事热点、专栏、微博平台等海量权威整合的网络内容共享资源,进行自动检索、推送、转载、分享、索引、过滤、筛选等的自主网络传播,快速找到想要的资讯。

包括各种实时、海量的新闻搜索、音频、视频等各类信息,自动评论、监督、分享,完全彻底解决用户对各类资讯获取获取的困难。

新闻聚合,这个模式的前途一片大好。前景如何,我们不如举例来说。在搜索引擎诞生之初,中国几乎所有的人和机构都离不开搜索引擎,因为当时没有百度,也没有莆田系医院等,但是我们自己通过输入一些关键词(比如,学生要去医院,要去银行)在搜索引擎上搜索,得到的结果每个网站都不相同。而在今天,由于大数据的应用,可以通过深度分析一个人大量的行为,就可以理解和推送各个网站最有用的资讯。

然而这种方式还是太过于粗放,只能满足我们一时的内容需求,而非广泛传播;如果有个新闻聚合的东西,汇聚了所有网站的所有有用资讯,而又不会做过分的深度分析,这是会大大提高我们整体获取信息的体验的,从而形成新闻聚合类内容的爆发期。 查看全部

资讯内容采集系统(资讯内容采集系统的前途一片大好前景如何?)

资讯内容采集系统采用先进的saas模式运营,完全地采用云端管理模式。集人工智能、大数据、机器学习、语音识别、ai、ai算法、软件开发、语音合成、人工智能的系统开发、教育技术的系统开发等于一体的大型服务平台。包括所有内容采集信息网站、公众号信息、官网信息、学校招生信息、学校招生专业库、教育局政策性文件、教育培训机构全国招生信息、新鲜事热点、专栏、微博平台等海量权威整合的网络内容共享资源,进行自动检索、推送、转载、分享、索引、过滤、筛选等的自主网络传播,快速找到想要的资讯。

包括各种实时、海量的新闻搜索、音频、视频等各类信息,自动评论、监督、分享,完全彻底解决用户对各类资讯获取获取的困难。

新闻聚合,这个模式的前途一片大好。前景如何,我们不如举例来说。在搜索引擎诞生之初,中国几乎所有的人和机构都离不开搜索引擎,因为当时没有百度,也没有莆田系医院等,但是我们自己通过输入一些关键词(比如,学生要去医院,要去银行)在搜索引擎上搜索,得到的结果每个网站都不相同。而在今天,由于大数据的应用,可以通过深度分析一个人大量的行为,就可以理解和推送各个网站最有用的资讯。

然而这种方式还是太过于粗放,只能满足我们一时的内容需求,而非广泛传播;如果有个新闻聚合的东西,汇聚了所有网站的所有有用资讯,而又不会做过分的深度分析,这是会大大提高我们整体获取信息的体验的,从而形成新闻聚合类内容的爆发期。

资讯内容采集系统(spring使用springcloud架构来做爬虫,历时二十多天,终于搞定)

采集交流 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2022-04-07 00:04

前言

因公司业务需要,需要获取客户提供的微信公众号历史文章,并每天更新。很明显,每天人工检查300多个公众号是不行的,把问题提交给IT团队。对于那些喜欢爬虫的人,我一定会尝试他。之前做过搜狗的微信爬虫,后来一直在做java web。这个项目重新点燃了我对爬虫的热爱。第一次使用spring cloud架构做爬虫。20多天后,终于搞定了。接下来我将通过一系列文章分享这个项目的经验,并提供源码供大家指正!

一、系统介绍

本系统是基于Java开发的。只需简单配置公众号或微信公众号的名称,即可定时或即时抓取微信公众号的文章(包括阅读次数、点赞次数、观看次数)。

二、系统架构

技术架构

Spring Cloud、Spring Boot、Mybatis-Plus、Nacos、RocketMq、nginx

贮存

Mysql、MongoDB、Redis、Solr

缓存

雷迪斯

演戏

提琴手

三、系统优缺点

系统优势

1、配置公众号后,可以通过Fiddler的JS注入功能和Websocket实现自动爬取;2、系统为分布式架构,高可用;3、RocketMq 消息队列用于解耦合,可以解决采集由于网络抖动导致的失败。如果3次消费不成功,日志会记录到mysql,保证文章的完整性;4、可以加入任意数量的微信号提高采集效率,抵抗反爬限制;5、Redis缓存24小时内每个微信号的采集记录,防止账号被封;6、Nacos作为一个配置中心,可以通过热配置来访问调整采集的频率 实时; 7、将数据采集存储到Solr集群,提高检索速度;8、将抓包返回的记录保存在MongoDB中,方便存档查看错误日志。

系统缺点:

1、通过真机真实账号采集消息,如果需要采集大量公众号,需要有多个微信账号作为支持(如果账号达到上限当天,可以通过爬虫界面爬取微信公众平台获取新闻);2、不是公众号一发就可以马上抢到消息,采集时间是系统设置的,消息有一定的延迟(如果没有公众号多,微信数量足够。通过增加采集频率进行优化)。

四、模块介绍

由于后面会添加管理系统和API调用功能,所以提前封装了一些功能。

common-ws-starter

公共模块:存储工具类、实体类等公共消息。

redis-ws-starter

Redis 模块:是的

spring-boot-starter-data-redis的二次封装暴露了封装后的Redis工具类和Redisson工具类。

火箭MQ-WS-启动器

RocketMq 模块:是

RocketMQ-spring-boot-starter的二次包,提供消费重试和失败日志记录功能。

db-ws-starter

mysql数据源模块:封装mysql数据源,支持多数据源,通过自定义注解实现数据源的动态切换。

sql-wx-蜘蛛

mysql数据库模块:提供mysql数据库操作的所有功能。

pc-wx-蜘蛛

PC端采集模块:收录PC端采集公众号历史消息相关功能。

java-wx-蜘蛛

Java抽取模块:收录java程序抽取文章内容相关的功能。

移动 wx 蜘蛛

模拟器采集模块:收录通过模拟器或移动端采集消息交互量相关的功能。

五、一般流程图

六、运行截图

个人电脑和手机

安慰

运行结束

总结

该项目的亲测可用性现已投入运行,在项目开发中解决了微信搜狗临时链接到永久链接的问题,希望能帮助被类似业务困扰的老铁们。如今,做java就像逆水行舟。不进则退。我不知道你什么时候会参与进来。我希望每个人都有自己的向日葵采集。你不给这个采集吗? 查看全部

资讯内容采集系统(spring使用springcloud架构来做爬虫,历时二十多天,终于搞定)

前言

因公司业务需要,需要获取客户提供的微信公众号历史文章,并每天更新。很明显,每天人工检查300多个公众号是不行的,把问题提交给IT团队。对于那些喜欢爬虫的人,我一定会尝试他。之前做过搜狗的微信爬虫,后来一直在做java web。这个项目重新点燃了我对爬虫的热爱。第一次使用spring cloud架构做爬虫。20多天后,终于搞定了。接下来我将通过一系列文章分享这个项目的经验,并提供源码供大家指正!

一、系统介绍

本系统是基于Java开发的。只需简单配置公众号或微信公众号的名称,即可定时或即时抓取微信公众号的文章(包括阅读次数、点赞次数、观看次数)。

二、系统架构

技术架构

Spring Cloud、Spring Boot、Mybatis-Plus、Nacos、RocketMq、nginx

贮存

Mysql、MongoDB、Redis、Solr

缓存

雷迪斯

演戏

提琴手

三、系统优缺点

系统优势

1、配置公众号后,可以通过Fiddler的JS注入功能和Websocket实现自动爬取;2、系统为分布式架构,高可用;3、RocketMq 消息队列用于解耦合,可以解决采集由于网络抖动导致的失败。如果3次消费不成功,日志会记录到mysql,保证文章的完整性;4、可以加入任意数量的微信号提高采集效率,抵抗反爬限制;5、Redis缓存24小时内每个微信号的采集记录,防止账号被封;6、Nacos作为一个配置中心,可以通过热配置来访问调整采集的频率 实时; 7、将数据采集存储到Solr集群,提高检索速度;8、将抓包返回的记录保存在MongoDB中,方便存档查看错误日志。

系统缺点:

1、通过真机真实账号采集消息,如果需要采集大量公众号,需要有多个微信账号作为支持(如果账号达到上限当天,可以通过爬虫界面爬取微信公众平台获取新闻);2、不是公众号一发就可以马上抢到消息,采集时间是系统设置的,消息有一定的延迟(如果没有公众号多,微信数量足够。通过增加采集频率进行优化)。

四、模块介绍

由于后面会添加管理系统和API调用功能,所以提前封装了一些功能。

common-ws-starter

公共模块:存储工具类、实体类等公共消息。

redis-ws-starter

Redis 模块:是的

spring-boot-starter-data-redis的二次封装暴露了封装后的Redis工具类和Redisson工具类。

火箭MQ-WS-启动器

RocketMq 模块:是

RocketMQ-spring-boot-starter的二次包,提供消费重试和失败日志记录功能。

db-ws-starter

mysql数据源模块:封装mysql数据源,支持多数据源,通过自定义注解实现数据源的动态切换。

sql-wx-蜘蛛

mysql数据库模块:提供mysql数据库操作的所有功能。

pc-wx-蜘蛛

PC端采集模块:收录PC端采集公众号历史消息相关功能。

java-wx-蜘蛛

Java抽取模块:收录java程序抽取文章内容相关的功能。

移动 wx 蜘蛛

模拟器采集模块:收录通过模拟器或移动端采集消息交互量相关的功能。

五、一般流程图

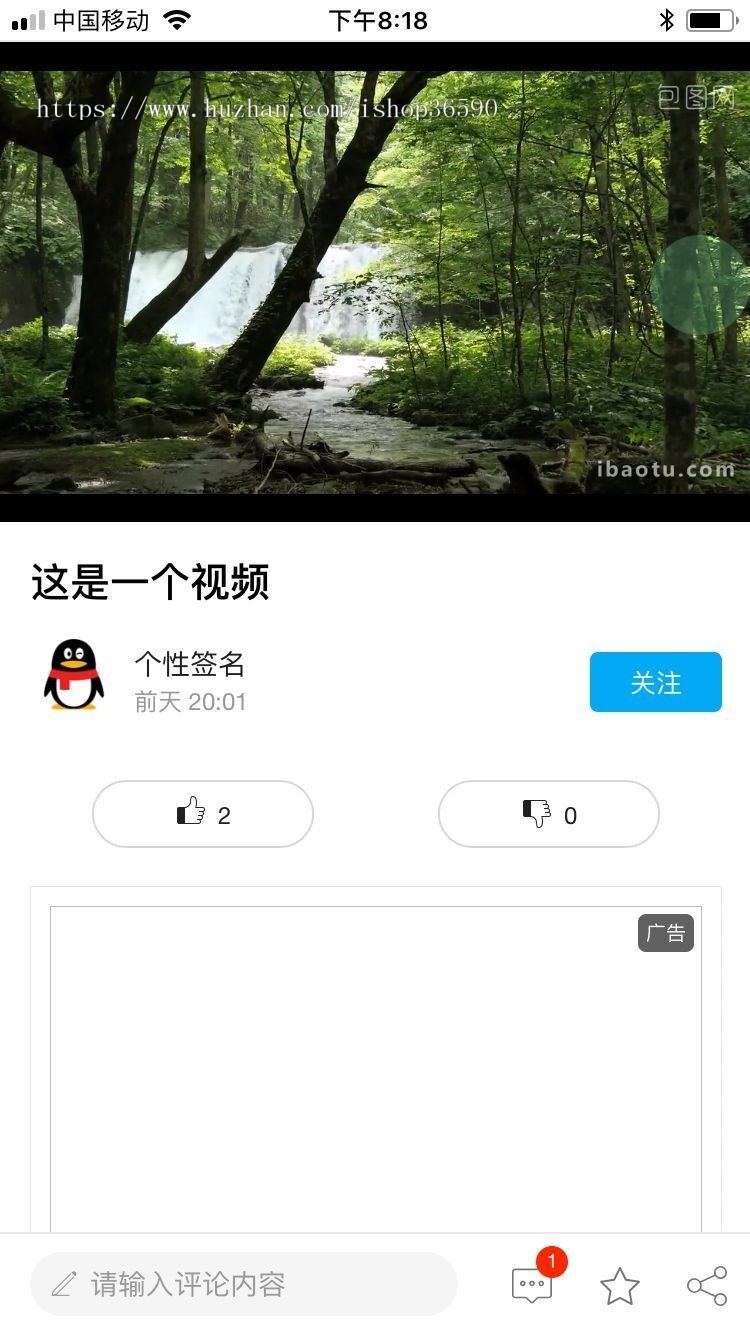

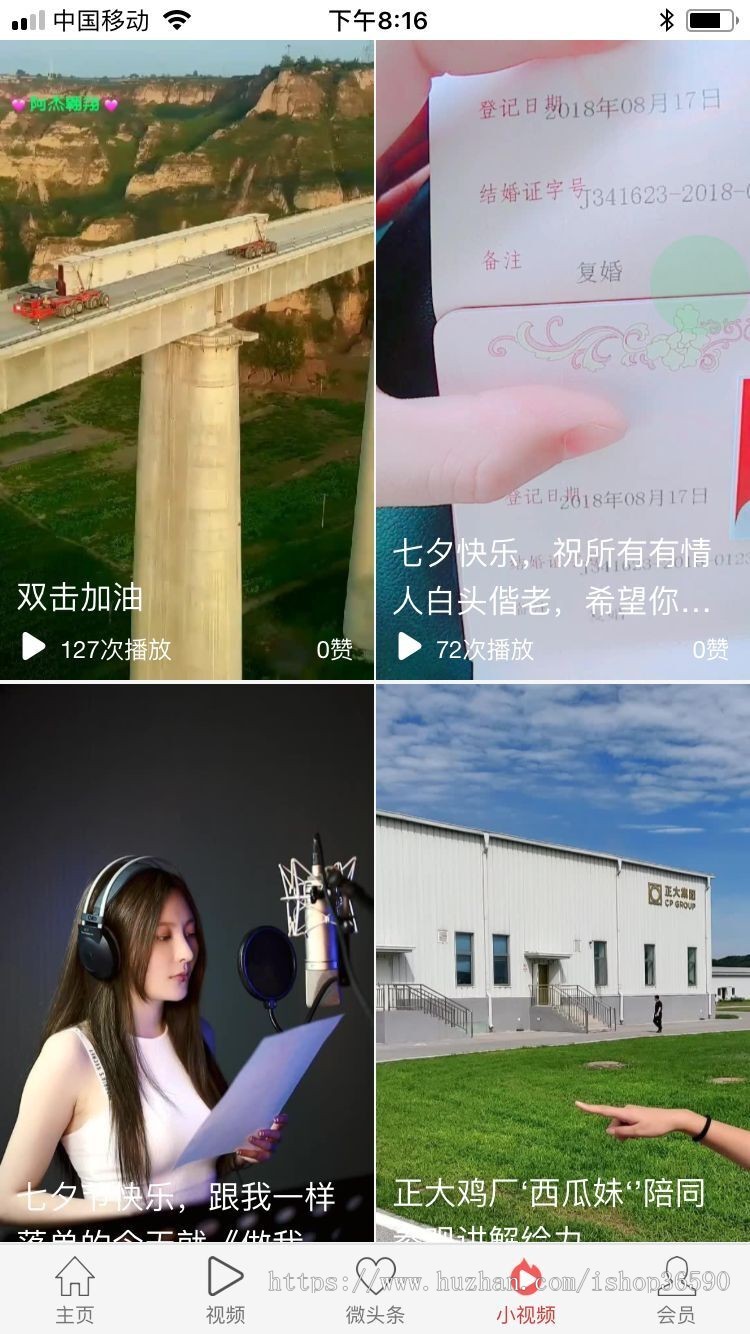

六、运行截图

个人电脑和手机

安慰

运行结束

总结

该项目的亲测可用性现已投入运行,在项目开发中解决了微信搜狗临时链接到永久链接的问题,希望能帮助被类似业务困扰的老铁们。如今,做java就像逆水行舟。不进则退。我不知道你什么时候会参与进来。我希望每个人都有自己的向日葵采集。你不给这个采集吗?

资讯内容采集系统(支持对查询次数限制作了限制的网站-支持境内外 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-04-07 00:02

)

支持 网站 限制查询次数

●支持用户名、密码、验证码、自动登录并回复

●支持海量资料采集,可下载各类文件

●自动获取动态IP功能,防止个别网站反监听

●数据增量采集,支持自动实时更新

●支持每种采集信息的自定义来源和分类

●支持智能采集替换功能,可去除广告等嵌入内容的所有无关部分,支持多页

Face文章自动提取合并内容

●支持记录唯一索引,避免重复存储相同信息

数据为采集后,直接压缩存储在Access、MY SQL、SQL Server等主流数据库中。

●对下载的信息进行管理、搜索、标记和传输,并设置专门的结果区进行分类和编辑

●支持数据导入导出:按指定批量数据(含附件);根据日期

●自动获取文章中的IP地址并解析对应的物理地址

●搜索任务可以手动定时启动【每天几点开始采集】

●扫描网站或需要监控的网址,跳过未自动更新的页面。

Ⅱ.情报分析

●支持搜索引擎检索(百度、google、msn等),可添加海外搜索引擎

●支持国内外目标网站、博客、论坛定位采集,可手动设置下载地址的优先级

●支持下载信息关键字(“and”、“or”)的组合检索

● 通过关键字监控下载或下载信息的内容,并自动保存到指定目录

●支持多种搜索语法

●整个互联网信息可以采集和

监视器。

三、软件架构

?软件架构清晰

软件架构图

3. 使用说明

3.1 软件安装

下载软件安装包:/downloads/KWebWatcher701.exe后,双击安装,选择默认安装方式,一直点击“下一步”按钮,直到软件安装完成。安装完成后

图1 开始安装

图 2 完成

图 3 启动软件

3.2 情报监控

3.2.1 添加情报分类

单击工具栏上的“”按钮,弹出如图9所示的对话框。输入类别名称。为了方便情报话题的分类和管理,软件中引入了情报类别。可以通过类别有效地管理阶段

关于该主题的情报信息。

图9 添加智能监控分类

3.2.2 添加监控主题

点击工具栏上的“”按钮,弹出如图10所示的对话框。选择监控类别后,输入一个名称来标识主题,如“西南干旱”。然后在“包括以下所有关键词”中输入一个或多个关键词:如“西南干旱”,每个关键词用空格隔开。

为了控制情报的质量,可以使用“并且收录以下任意一项关键词”和“不收录以下全部关键词”

在 .

图10 添加智能监控主题

图 11 监测结果

3.3 采集部署

最新版软件目前提供五种模式的智能采集部署方案。我们可以在工具栏上找到 Open for deployment。您也可以在“情报监控首页”面板的“情报采集部署”组中打开相应的界面来部署采集。这些方法是:监控指定网站、监控指定论坛、监控全网、监控指定集群新闻链接和推荐采集站点列表采集。下面,我们一一介绍。

3.3.1 采集指定网站

在实际应用中,我们经常需要持续监控某个网站,监控与我们关注点相关的情报。这样就可以点击工具栏中的“”按钮,弹出如图4所示的界面。

图4 采集指定的网站

在“网站Address”字段中输入您需要监控的站点地址,例如。如果还需要监听网站下面的其他子频道,可以点击旁边的“”按钮,软件会遍历本站的链接地址,展开其他子频道。根据需要勾选子频道。

选择一个保存渠道,为了方便以后站点数量持续增长时对站点的管理,我们需要预先建一个站点保存类别,然后在这里选择指定的类别。然后该站点将保存到指定的类别。

,如果我们同时选择网站的以下子通道,我们还需要

点击分类管理,可以勾选此项。

采集深度:如果我们需要对网站进行全面监控,可以将采集深度设置为2级或更高,设置越高,监控一个网站@ > 需要的时间越长。如果需要全站监控,一般设置为3-5就足够了。

我们也可以为网站的采集指定智能监控主题,或者不指定,默认监控当前库中的所有主题。

3.3.2 选择推荐网站

除了指定采集网站,我们还可以从软件预设网站中选择监控网站。目前,软件中有2万多个网站预设,覆盖全国35个行业的主要媒体和企业网站。在主面板下

“”打开如图5所示界面。

图 5 推荐的 采集 站点

在左侧的导航树上,我们选择一个类别,该类别下的所有推荐网站信息都会加载到右侧对应的列表中。只需勾选需要监控的网站记录前面的网站即可。然后单击“确定”按钮。达到监控网站的目的。这里我们也可以选择监控对象,或者默认监控全部。

3.3.3 监控网站论坛

点击工具栏上的“”按钮,弹出如图6所示的对话框。输入您要监控的一项

比如点击后面的“”按钮后,软件会自动识别论坛的模板,提取论坛的各个子版块。用户可以查看需要监控的子部分。

选择一个保存频道。如果您需要单独保存每个子频道,可以勾选“自动在该频道下创建子频道”选项。

智能监控主题可以为网站的采集指定,也可以不指定,默认监控当前库中的所有主题。

图 6 网站 论坛监控

3.3.4 全网监控

点击工具栏上的“”按钮,弹出如图7所示的对话框。输入一个需要监控的

关键词 的。关键词您可以输入多个,以空格分隔。如需全网监控广州BRT相关信息,可进入“广州BRT”,在下方搜索引擎列表中查看指定搜索引擎。然后选择一个保存通道来保存站点和它采集到的信息。

同理,可以为网站的采集指定智能监控主题,也可以不指定,默认监控当前库中的所有主题。

图7 全网监控

3.3.5 集群信息监控

聚类信息是WEB2.0 的产物。网站管理员动态生成的聚类信息采集了某类目标网站的最新信息。监控也是可能的。单击工具栏上的

“”按钮,弹出如图8所示的对话框。

图8 集群信息监控

3.4 生成简报

在这里,您可以将选定的情报整合到此时事通讯中,或下载它。这里有 2 种下载格式,word 和 excel。单词下载可以下载全文。Excel 下载包括新闻标题、新闻来源、发布日期和原创文本的链接,但不包括文本。还可以生成此问题中所有情报的可视化呈现,如图 12 所示。

图 12 情报简报

4. 监控示例

某政府部门:构建智能新闻舆情监测系统

中外新闻舆情的采集和分析是政府部门的主要基础工作。为面对当前网络媒体蓬勃发展的新趋势,借助先进的IT技术,提高新闻监测的覆盖面、实时性和工作效率,某政府部门构建了中外新闻舆情使用“即时互联网舆情监测系统”进行监测。,从而实现自动采集、通讯社新闻、互联网网站新闻和电视新闻的分类和排序等功能,可以方便快捷地掌握以各种形式传播到世界各地的新闻报道通过内部网络系统。

中外新闻舆情监测系统的实施大大提高了某新闻部门的实时采集和采集效率,减少了工作人员采集的工作量,使某个部门的工作人员有更多的时间和精力投入到新闻分析中,为领导决策提供更好的服务和参考。

北京市工商行政管理局:基于互联网信息的食品安全预警

食品安全是事关国计民生的重大问题。食品安全监测体系建设是2005年北京市政府对民营企业实施的55个实战项目之一。随着互联网的普及,互联网所收录的信息和价值越来越大,互联网监控也成为食品安全监控的重要组成部分。事件的发展和传播,同时通过了解网友对食品质量的反馈,及时发现安全隐患等。

<p>北京食品安全监测系统采用“互联网即时舆情监测系统”,实现对互联网信息的实时采集和监测,全面监测重大网站、行业 查看全部

资讯内容采集系统(支持对查询次数限制作了限制的网站-支持境内外

)

支持 网站 限制查询次数

●支持用户名、密码、验证码、自动登录并回复

●支持海量资料采集,可下载各类文件

●自动获取动态IP功能,防止个别网站反监听

●数据增量采集,支持自动实时更新

●支持每种采集信息的自定义来源和分类

●支持智能采集替换功能,可去除广告等嵌入内容的所有无关部分,支持多页

Face文章自动提取合并内容

●支持记录唯一索引,避免重复存储相同信息

数据为采集后,直接压缩存储在Access、MY SQL、SQL Server等主流数据库中。

●对下载的信息进行管理、搜索、标记和传输,并设置专门的结果区进行分类和编辑

●支持数据导入导出:按指定批量数据(含附件);根据日期

●自动获取文章中的IP地址并解析对应的物理地址

●搜索任务可以手动定时启动【每天几点开始采集】

●扫描网站或需要监控的网址,跳过未自动更新的页面。

Ⅱ.情报分析

●支持搜索引擎检索(百度、google、msn等),可添加海外搜索引擎

●支持国内外目标网站、博客、论坛定位采集,可手动设置下载地址的优先级

●支持下载信息关键字(“and”、“or”)的组合检索

● 通过关键字监控下载或下载信息的内容,并自动保存到指定目录

●支持多种搜索语法

●整个互联网信息可以采集和

监视器。

三、软件架构

?软件架构清晰

软件架构图

3. 使用说明

3.1 软件安装

下载软件安装包:/downloads/KWebWatcher701.exe后,双击安装,选择默认安装方式,一直点击“下一步”按钮,直到软件安装完成。安装完成后

图1 开始安装

图 2 完成

图 3 启动软件

3.2 情报监控

3.2.1 添加情报分类

单击工具栏上的“”按钮,弹出如图9所示的对话框。输入类别名称。为了方便情报话题的分类和管理,软件中引入了情报类别。可以通过类别有效地管理阶段

关于该主题的情报信息。

图9 添加智能监控分类

3.2.2 添加监控主题

点击工具栏上的“”按钮,弹出如图10所示的对话框。选择监控类别后,输入一个名称来标识主题,如“西南干旱”。然后在“包括以下所有关键词”中输入一个或多个关键词:如“西南干旱”,每个关键词用空格隔开。

为了控制情报的质量,可以使用“并且收录以下任意一项关键词”和“不收录以下全部关键词”

在 .

图10 添加智能监控主题

图 11 监测结果

3.3 采集部署

最新版软件目前提供五种模式的智能采集部署方案。我们可以在工具栏上找到 Open for deployment。您也可以在“情报监控首页”面板的“情报采集部署”组中打开相应的界面来部署采集。这些方法是:监控指定网站、监控指定论坛、监控全网、监控指定集群新闻链接和推荐采集站点列表采集。下面,我们一一介绍。

3.3.1 采集指定网站

在实际应用中,我们经常需要持续监控某个网站,监控与我们关注点相关的情报。这样就可以点击工具栏中的“”按钮,弹出如图4所示的界面。

图4 采集指定的网站

在“网站Address”字段中输入您需要监控的站点地址,例如。如果还需要监听网站下面的其他子频道,可以点击旁边的“”按钮,软件会遍历本站的链接地址,展开其他子频道。根据需要勾选子频道。

选择一个保存渠道,为了方便以后站点数量持续增长时对站点的管理,我们需要预先建一个站点保存类别,然后在这里选择指定的类别。然后该站点将保存到指定的类别。

,如果我们同时选择网站的以下子通道,我们还需要

点击分类管理,可以勾选此项。

采集深度:如果我们需要对网站进行全面监控,可以将采集深度设置为2级或更高,设置越高,监控一个网站@ > 需要的时间越长。如果需要全站监控,一般设置为3-5就足够了。

我们也可以为网站的采集指定智能监控主题,或者不指定,默认监控当前库中的所有主题。

3.3.2 选择推荐网站

除了指定采集网站,我们还可以从软件预设网站中选择监控网站。目前,软件中有2万多个网站预设,覆盖全国35个行业的主要媒体和企业网站。在主面板下

“”打开如图5所示界面。

图 5 推荐的 采集 站点

在左侧的导航树上,我们选择一个类别,该类别下的所有推荐网站信息都会加载到右侧对应的列表中。只需勾选需要监控的网站记录前面的网站即可。然后单击“确定”按钮。达到监控网站的目的。这里我们也可以选择监控对象,或者默认监控全部。

3.3.3 监控网站论坛

点击工具栏上的“”按钮,弹出如图6所示的对话框。输入您要监控的一项

比如点击后面的“”按钮后,软件会自动识别论坛的模板,提取论坛的各个子版块。用户可以查看需要监控的子部分。

选择一个保存频道。如果您需要单独保存每个子频道,可以勾选“自动在该频道下创建子频道”选项。

智能监控主题可以为网站的采集指定,也可以不指定,默认监控当前库中的所有主题。

图 6 网站 论坛监控

3.3.4 全网监控

点击工具栏上的“”按钮,弹出如图7所示的对话框。输入一个需要监控的

关键词 的。关键词您可以输入多个,以空格分隔。如需全网监控广州BRT相关信息,可进入“广州BRT”,在下方搜索引擎列表中查看指定搜索引擎。然后选择一个保存通道来保存站点和它采集到的信息。

同理,可以为网站的采集指定智能监控主题,也可以不指定,默认监控当前库中的所有主题。

图7 全网监控

3.3.5 集群信息监控

聚类信息是WEB2.0 的产物。网站管理员动态生成的聚类信息采集了某类目标网站的最新信息。监控也是可能的。单击工具栏上的

“”按钮,弹出如图8所示的对话框。

图8 集群信息监控

3.4 生成简报

在这里,您可以将选定的情报整合到此时事通讯中,或下载它。这里有 2 种下载格式,word 和 excel。单词下载可以下载全文。Excel 下载包括新闻标题、新闻来源、发布日期和原创文本的链接,但不包括文本。还可以生成此问题中所有情报的可视化呈现,如图 12 所示。

图 12 情报简报

4. 监控示例

某政府部门:构建智能新闻舆情监测系统

中外新闻舆情的采集和分析是政府部门的主要基础工作。为面对当前网络媒体蓬勃发展的新趋势,借助先进的IT技术,提高新闻监测的覆盖面、实时性和工作效率,某政府部门构建了中外新闻舆情使用“即时互联网舆情监测系统”进行监测。,从而实现自动采集、通讯社新闻、互联网网站新闻和电视新闻的分类和排序等功能,可以方便快捷地掌握以各种形式传播到世界各地的新闻报道通过内部网络系统。

中外新闻舆情监测系统的实施大大提高了某新闻部门的实时采集和采集效率,减少了工作人员采集的工作量,使某个部门的工作人员有更多的时间和精力投入到新闻分析中,为领导决策提供更好的服务和参考。

北京市工商行政管理局:基于互联网信息的食品安全预警

食品安全是事关国计民生的重大问题。食品安全监测体系建设是2005年北京市政府对民营企业实施的55个实战项目之一。随着互联网的普及,互联网所收录的信息和价值越来越大,互联网监控也成为食品安全监控的重要组成部分。事件的发展和传播,同时通过了解网友对食品质量的反馈,及时发现安全隐患等。

<p>北京食品安全监测系统采用“互联网即时舆情监测系统”,实现对互联网信息的实时采集和监测,全面监测重大网站、行业

资讯内容采集系统(基于内容和主题的个性化新闻推荐系统设计与实现需求分析)

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2022-04-05 17:00

基于内容和话题需求分析的个性化新闻推荐系统的设计与实现流程:

基于内容和主题的个性化新闻推荐系统设计与实现需求分析原理示意图

本设计符合基于内容和主题的个性化新闻推荐系统的设计与实现开篇报告中的通用实现方法。

2.1 设计目标

在该新闻推荐系统中,对网站中用户浏览记录的cookie文件进行大量数据处理,从而实现对用户特征行为和独特兴趣的精准分析,充分推送用户可能的感受为他们。针对感兴趣的内容和话题的新闻个性化推荐系统。首先,系统对大量新闻资源进行大规模数据挖掘,得到完整的新闻话题集。每个新闻主题(由 关键词 描述)都与多个新闻报道相关联。个性化的新闻推荐服务提供精准的推荐依据。然后,网站系统后台为每个用户建立对应的兴趣模型,根据用户浏览的关键词浏览量进行排序,并通过提取cookies记录用户浏览新闻时当前页面的各种操作行为。实时更新修正每个用户的兴趣模型,不断强化记忆。每当用户下次访问同一个网站时,系统后台会根据用户的模型数据连接本地服务,向用户推荐用户。喜欢的内容。

需要解决的五个关键节点问题:

问题一:新闻采集发布实时同步和缓存处理。

问题二:如何从海量的新闻数据资源中进行话题发现。

问题3:为用户建立一个合适的模型来描述用户的兴趣和偏好。

问题四:在向用户推荐新闻时,要同时保证实时性和准确性。

问题5:如何安排新闻的推荐顺序。

2.1.1 功能需求分析

本系统主要分为三部分:推荐系统设计与实现,网站前端设计,网站后端设计。

推荐系统的算法设计和实现主要用到:基于主题相似度的推荐、基于内容关键词的推荐、时敏权重计算、匹配算法、主题分组和记忆模型算法。

2.2 新闻推荐系统整体设计原理

推荐系统的整体推荐原理如图2.1所示。

从推荐系统操作的角度来看,系统分为离线操作模块和在线操作模块。

离线运行模块的运行周期以天为单位,其主要功能如下:

对每次更新进来的新闻数据源进行主题发现,获取代表新闻主题的关键词组合的集合,以及新闻主题下的相关新闻内容。

实时记录不断生成的浏览和点击行为cookie文件,并将内容同步到用户数据库,从而不断更新用户兴趣模型,更新数据库。

在线操作模块的操作是实时的,其主要功能如下:

当用户访问网站时,首先判断后台用户数据库中是否有该用户的信息:如果有,根据用户原有的兴趣模型为用户推荐个性化新闻;如果不是,则为用户建立相应的兴趣模型。

通过cookies跟踪记录用户的点击浏览行为,并将记录添加到网站后台对应的用户模型文件的相应目录中。

本文由91天堂网综合整理。欢迎转载分享,但请注明出处和地址,违者必究。 查看全部

资讯内容采集系统(基于内容和主题的个性化新闻推荐系统设计与实现需求分析)

基于内容和话题需求分析的个性化新闻推荐系统的设计与实现流程:

基于内容和主题的个性化新闻推荐系统设计与实现需求分析原理示意图

本设计符合基于内容和主题的个性化新闻推荐系统的设计与实现开篇报告中的通用实现方法。

2.1 设计目标

在该新闻推荐系统中,对网站中用户浏览记录的cookie文件进行大量数据处理,从而实现对用户特征行为和独特兴趣的精准分析,充分推送用户可能的感受为他们。针对感兴趣的内容和话题的新闻个性化推荐系统。首先,系统对大量新闻资源进行大规模数据挖掘,得到完整的新闻话题集。每个新闻主题(由 关键词 描述)都与多个新闻报道相关联。个性化的新闻推荐服务提供精准的推荐依据。然后,网站系统后台为每个用户建立对应的兴趣模型,根据用户浏览的关键词浏览量进行排序,并通过提取cookies记录用户浏览新闻时当前页面的各种操作行为。实时更新修正每个用户的兴趣模型,不断强化记忆。每当用户下次访问同一个网站时,系统后台会根据用户的模型数据连接本地服务,向用户推荐用户。喜欢的内容。

需要解决的五个关键节点问题:

问题一:新闻采集发布实时同步和缓存处理。

问题二:如何从海量的新闻数据资源中进行话题发现。

问题3:为用户建立一个合适的模型来描述用户的兴趣和偏好。

问题四:在向用户推荐新闻时,要同时保证实时性和准确性。

问题5:如何安排新闻的推荐顺序。

2.1.1 功能需求分析

本系统主要分为三部分:推荐系统设计与实现,网站前端设计,网站后端设计。

推荐系统的算法设计和实现主要用到:基于主题相似度的推荐、基于内容关键词的推荐、时敏权重计算、匹配算法、主题分组和记忆模型算法。

2.2 新闻推荐系统整体设计原理

推荐系统的整体推荐原理如图2.1所示。

从推荐系统操作的角度来看,系统分为离线操作模块和在线操作模块。

离线运行模块的运行周期以天为单位,其主要功能如下:

对每次更新进来的新闻数据源进行主题发现,获取代表新闻主题的关键词组合的集合,以及新闻主题下的相关新闻内容。

实时记录不断生成的浏览和点击行为cookie文件,并将内容同步到用户数据库,从而不断更新用户兴趣模型,更新数据库。

在线操作模块的操作是实时的,其主要功能如下:

当用户访问网站时,首先判断后台用户数据库中是否有该用户的信息:如果有,根据用户原有的兴趣模型为用户推荐个性化新闻;如果不是,则为用户建立相应的兴趣模型。

通过cookies跟踪记录用户的点击浏览行为,并将记录添加到网站后台对应的用户模型文件的相应目录中。

本文由91天堂网综合整理。欢迎转载分享,但请注明出处和地址,违者必究。

资讯内容采集系统(任意数据采集,快速网站建设,数据同步和舆情监控)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2022-04-01 02:05

任意数据采集、快速网站构建、数据同步和舆情监测。

资讯采集软件中性价比最高的软件;最常用的软件;使用寿命最长的软件。

1.强大的信息采集功能。可以采集几乎任何类型的网站信息,包括静态htm、html类型和动态ASP、ASPX、JSP等。N级页面可以与采集关联,并自动集成成完整的记录。支持网络框架、链接和网络加密等。支持完整的采集和增量的采集(从断点继续)。可以自动下载二进制文件,如图片、软件、mp3等。可用的采集本地磁盘信息。支持 Post 数据请求 采集 方法。

2.网站登录。只能登录才能查看的信息,先在任务的“登录设置”中登录,采集登录后才能查看的信息。

3.速度快,运行稳定。真正的多线程、多任务,运行时占用系统资源少,可长时间稳定运行。(明显不同于其他软件)4.数据保存格式丰富。采集的数据可以保存为Txt、Excel以及各种数据库格式(Access sqlserver Oracle Mysql等)。

5.支持脚本。可以设置脚本类型的任务,类似javascript:submit('Page', 1)等格式都可以轻松采集。

6.强大的新闻采集,自动化处理。新闻的格式可以自动保存,包括图片等(可以通过设置自动去除广告)。通过设置可以自动下载图片,将文中图片的网络路径自动更改为本地文件路径(也可以保持原样);采集的消息可以自动处理成自己设计的模板格式;采集 带有分页的新闻。通过这些功能,无需人工干预,只需简单设置即可在本地构建强大的新闻系统。

7.强大的信息自动再处理功能。对于采集的信息,可以进行二次批量再处理,使其更符合您的实际要求。还可以设置自动处理公式,在采集的过程中,根据公式进行自动处理,包括数据合并、数据替换等。

8.提供从采集,到自动化处理,到数据导出(发布)的一站式自动化功能。通过任务调度进行实时监控和发布。指定某些任务自动运行,自动去重后将采集的数据导入数据库(可以指定唯一的组合)。它可以循环往复。可以指定任务在某个时间点运行。设置采集一定数量的数据后,会自动存入库,内存会自动清空。该功能可以连续不间断地采集100,000和100,000级别的数据,同时占用很少的系统资源。让它无人看管采集。 查看全部

资讯内容采集系统(任意数据采集,快速网站建设,数据同步和舆情监控)

任意数据采集、快速网站构建、数据同步和舆情监测。

资讯采集软件中性价比最高的软件;最常用的软件;使用寿命最长的软件。

1.强大的信息采集功能。可以采集几乎任何类型的网站信息,包括静态htm、html类型和动态ASP、ASPX、JSP等。N级页面可以与采集关联,并自动集成成完整的记录。支持网络框架、链接和网络加密等。支持完整的采集和增量的采集(从断点继续)。可以自动下载二进制文件,如图片、软件、mp3等。可用的采集本地磁盘信息。支持 Post 数据请求 采集 方法。

2.网站登录。只能登录才能查看的信息,先在任务的“登录设置”中登录,采集登录后才能查看的信息。

3.速度快,运行稳定。真正的多线程、多任务,运行时占用系统资源少,可长时间稳定运行。(明显不同于其他软件)4.数据保存格式丰富。采集的数据可以保存为Txt、Excel以及各种数据库格式(Access sqlserver Oracle Mysql等)。

5.支持脚本。可以设置脚本类型的任务,类似javascript:submit('Page', 1)等格式都可以轻松采集。

6.强大的新闻采集,自动化处理。新闻的格式可以自动保存,包括图片等(可以通过设置自动去除广告)。通过设置可以自动下载图片,将文中图片的网络路径自动更改为本地文件路径(也可以保持原样);采集的消息可以自动处理成自己设计的模板格式;采集 带有分页的新闻。通过这些功能,无需人工干预,只需简单设置即可在本地构建强大的新闻系统。

7.强大的信息自动再处理功能。对于采集的信息,可以进行二次批量再处理,使其更符合您的实际要求。还可以设置自动处理公式,在采集的过程中,根据公式进行自动处理,包括数据合并、数据替换等。

8.提供从采集,到自动化处理,到数据导出(发布)的一站式自动化功能。通过任务调度进行实时监控和发布。指定某些任务自动运行,自动去重后将采集的数据导入数据库(可以指定唯一的组合)。它可以循环往复。可以指定任务在某个时间点运行。设置采集一定数量的数据后,会自动存入库,内存会自动清空。该功能可以连续不间断地采集100,000和100,000级别的数据,同时占用很少的系统资源。让它无人看管采集。

资讯内容采集系统(大数据平台日志数据采集方法(图)采集系统)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2022-03-30 09:09

任何一个完整的大数据平台一般都包括以下流程:数据采集 -> 数据存储 -> 数据处理 -> 数据呈现(可视化、报告和监控)。其中,data采集是所有数据系统中不可或缺的。随着对大数据的日益关注,数据采集的挑战变得尤为突出。

常用大数据采集方法

离线采集

在数据仓库的语境中,ETL基本上是数据采集的代表,包括数据抽取(Extract)、转换(Transform)和加载(Load)。在转换过程中,需要针对特定业务场景进行数据管理,如非法数据监控过滤、格式转换与数据规范化、数据替换、数据完整性保证等。

直播采集

实时采集主要用于考虑流处理的业务场景,例如记录数据源执行的各种操作活动,如网络监控的流量管理、金融应用的存量核算、用户记录等。 Web 服务器访问行为。该过程类似于传统的 ETL,但它是一种流处理方法,而不是定时批处理作业。这些工具均采用分布式架构,能够满足每秒数百MB的日志数据采集和传输需求。

系统日志采集方法

很多公司的业务平台每天都会产生大量的日志数据。对于这些日志信息,我们可以得到很多有价值的数据。通过记录采集,采集和分析这些日志信息,可以挖掘公司业务平台日志数据的潜在价值。

数据库采集 方法

一些企业会使用 MySQL、Oracle 等传统的关系型数据库来存储数据。数据库采集系统直接与企业业务后端服务器结合,每时每刻将企业业务后端产生的大量业务记录写入数据库,最后通过具体处理对系统进行分析系统。

其他数据采集方法

对于客户数据、财务数据等对企业生产经营数据保密要求较高的数据,您可以与数据技术服务商合作,使用特定的系统接口等相关方法对采集数据进行处理。

随着互联网技术的发展,各种互联网应用不断出现,人们的衣食住行都离不开互联网。互联网上的各种信息也呈指数级增长,如何在这些信息中快速准确地找到需要的信息变得极为重要。为了解决这个问题,搜索引擎技术应运而生。网络数据采集技术是搜索引擎技术的关键组成部分,搜索引擎所收录的海量数据是通过网络数据采集系统获取的。大数据采集新方法

网页信息采集技术又称网络爬虫,英文名称为WebCrawler,是一种按照一定的规则和算法不断扫描页面信息的程序或脚本。网络爬虫在运行过程中,不断提取网页中的各种数据。这些数据可用于搜索引擎关键词提取、索引建立、项目决策者数据支持、舆情分析等诸多领域。在工作中提供参考。

网络数据采集优势网络数据适用场景

网络数据采集是挖掘数据价值的第一步。当数据量越来越大时,必然会有更多有用的数据可以提取出来。只要用好数据处理平台,就能保证数据分析结果的有效性,帮助企业实现数据驱动。作为成都本地专业的DaaS服务商(数据即服务),斯堪玛科技以顶级高端人才和技术团队为支撑,为政府、医疗、交通、旅游、金融、教育等提供高效的网络服务、企业等领域。数据采集解决方案。返回搜狐,查看更多 查看全部

资讯内容采集系统(大数据平台日志数据采集方法(图)采集系统)

任何一个完整的大数据平台一般都包括以下流程:数据采集 -> 数据存储 -> 数据处理 -> 数据呈现(可视化、报告和监控)。其中,data采集是所有数据系统中不可或缺的。随着对大数据的日益关注,数据采集的挑战变得尤为突出。

常用大数据采集方法

离线采集

在数据仓库的语境中,ETL基本上是数据采集的代表,包括数据抽取(Extract)、转换(Transform)和加载(Load)。在转换过程中,需要针对特定业务场景进行数据管理,如非法数据监控过滤、格式转换与数据规范化、数据替换、数据完整性保证等。

直播采集

实时采集主要用于考虑流处理的业务场景,例如记录数据源执行的各种操作活动,如网络监控的流量管理、金融应用的存量核算、用户记录等。 Web 服务器访问行为。该过程类似于传统的 ETL,但它是一种流处理方法,而不是定时批处理作业。这些工具均采用分布式架构,能够满足每秒数百MB的日志数据采集和传输需求。

系统日志采集方法

很多公司的业务平台每天都会产生大量的日志数据。对于这些日志信息,我们可以得到很多有价值的数据。通过记录采集,采集和分析这些日志信息,可以挖掘公司业务平台日志数据的潜在价值。

数据库采集 方法

一些企业会使用 MySQL、Oracle 等传统的关系型数据库来存储数据。数据库采集系统直接与企业业务后端服务器结合,每时每刻将企业业务后端产生的大量业务记录写入数据库,最后通过具体处理对系统进行分析系统。

其他数据采集方法

对于客户数据、财务数据等对企业生产经营数据保密要求较高的数据,您可以与数据技术服务商合作,使用特定的系统接口等相关方法对采集数据进行处理。

随着互联网技术的发展,各种互联网应用不断出现,人们的衣食住行都离不开互联网。互联网上的各种信息也呈指数级增长,如何在这些信息中快速准确地找到需要的信息变得极为重要。为了解决这个问题,搜索引擎技术应运而生。网络数据采集技术是搜索引擎技术的关键组成部分,搜索引擎所收录的海量数据是通过网络数据采集系统获取的。大数据采集新方法

网页信息采集技术又称网络爬虫,英文名称为WebCrawler,是一种按照一定的规则和算法不断扫描页面信息的程序或脚本。网络爬虫在运行过程中,不断提取网页中的各种数据。这些数据可用于搜索引擎关键词提取、索引建立、项目决策者数据支持、舆情分析等诸多领域。在工作中提供参考。

网络数据采集优势网络数据适用场景

网络数据采集是挖掘数据价值的第一步。当数据量越来越大时,必然会有更多有用的数据可以提取出来。只要用好数据处理平台,就能保证数据分析结果的有效性,帮助企业实现数据驱动。作为成都本地专业的DaaS服务商(数据即服务),斯堪玛科技以顶级高端人才和技术团队为支撑,为政府、医疗、交通、旅游、金融、教育等提供高效的网络服务、企业等领域。数据采集解决方案。返回搜狐,查看更多

资讯内容采集系统(大数据、云计算是移动化多平台时代的windows软件)

采集交流 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-03-28 16:04

大数据和云计算是当今互联网上使用最广泛的技术。面对数据的蓝海,很多公司和个人并不完全具备数据挖掘能力,只能使用第三方爬虫软件来实现数据采集,传统的采集软件大多是依附于windows系统,现在是移动多平台时代,单一windows软件无法满足网站多种需求,成本昂贵,云同步能力差,导致钱网站 效果也微乎其微。有技术能力的公司或个人会自行开发符合自己网站的采集方案,这需要大量的人员、周期和成本投入,并且程序的可扩展性和通用性将在后期保持。会有明显的弊端,会消耗人力、物力和财力。

那么什么样的采集软件对网站真正有价值,笔者认为既要具备与传统采集软件一样的数据挖掘能力,又要跟上次要真正实现采集云化,市场上的云采集只在供应商的服务器上执行采集,客户没有完全的自主权,采集的效率受限于供应商服务器的处理能力,优采云采集器是真正的云数据采集发布系统,类似于cms建站系统,可以安装在客户自己的服务器上,可以通过浏览器访问服务器域名或ip来操作采集。优采云采集器与客户自己的没有冲突< @网站,完全是辅助采集。@网站采集系统可以建立在服务器的任意子目录下,不用时可以删除软件所在目录。

优采云采集器全称优采云数据采集发布系统,软件英文名为SkyCaiji,致力于网站数据自动化采集发布、制作数据采集便捷、智能、云端。软件是用php+mysql开发的可视化网站系统,开源免费使用,可以采集各类网页,可以自定义采集规则,支持正则表达式,XPATH 、JSON等多种语法,精准匹配任意信息流,智能识别大部分文章类型页面的正文内容。软件可配合各种cms建站程序实现无需登录即可实时发布数据,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,并生成API接口。软件可自动采集定时定量发布,无需人工干预,节省人力物力!操作界面完美适配电脑端和移动端,功能一致,让您随时随地工作。内置云平台,用户可以分享下载采集规则,发布采集供求信息,社区帮助交流。是网站数据自动化采集在大数据和云时代发布的最好的云爬虫软件。操作界面完美适配电脑端和移动端,功能一致,让您随时随地工作。内置云平台,用户可以分享下载采集规则,发布采集供求信息,社区帮助交流。是网站数据自动化采集在大数据和云时代发布的最好的云爬虫软件。操作界面完美适配电脑端和移动端,功能一致,让您随时随地工作。内置云平台,用户可以分享下载采集规则,发布采集供求信息,社区帮助交流。是网站数据自动化采集在大数据和云时代发布的最好的云爬虫软件。

专业的东西交给专人,优采云采集()会竭尽全力为您提供一套数据采集发布解决方案! 查看全部

资讯内容采集系统(大数据、云计算是移动化多平台时代的windows软件)

大数据和云计算是当今互联网上使用最广泛的技术。面对数据的蓝海,很多公司和个人并不完全具备数据挖掘能力,只能使用第三方爬虫软件来实现数据采集,传统的采集软件大多是依附于windows系统,现在是移动多平台时代,单一windows软件无法满足网站多种需求,成本昂贵,云同步能力差,导致钱网站 效果也微乎其微。有技术能力的公司或个人会自行开发符合自己网站的采集方案,这需要大量的人员、周期和成本投入,并且程序的可扩展性和通用性将在后期保持。会有明显的弊端,会消耗人力、物力和财力。

那么什么样的采集软件对网站真正有价值,笔者认为既要具备与传统采集软件一样的数据挖掘能力,又要跟上次要真正实现采集云化,市场上的云采集只在供应商的服务器上执行采集,客户没有完全的自主权,采集的效率受限于供应商服务器的处理能力,优采云采集器是真正的云数据采集发布系统,类似于cms建站系统,可以安装在客户自己的服务器上,可以通过浏览器访问服务器域名或ip来操作采集。优采云采集器与客户自己的没有冲突< @网站,完全是辅助采集。@网站采集系统可以建立在服务器的任意子目录下,不用时可以删除软件所在目录。

优采云采集器全称优采云数据采集发布系统,软件英文名为SkyCaiji,致力于网站数据自动化采集发布、制作数据采集便捷、智能、云端。软件是用php+mysql开发的可视化网站系统,开源免费使用,可以采集各类网页,可以自定义采集规则,支持正则表达式,XPATH 、JSON等多种语法,精准匹配任意信息流,智能识别大部分文章类型页面的正文内容。软件可配合各种cms建站程序实现无需登录即可实时发布数据,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,并生成API接口。软件可自动采集定时定量发布,无需人工干预,节省人力物力!操作界面完美适配电脑端和移动端,功能一致,让您随时随地工作。内置云平台,用户可以分享下载采集规则,发布采集供求信息,社区帮助交流。是网站数据自动化采集在大数据和云时代发布的最好的云爬虫软件。操作界面完美适配电脑端和移动端,功能一致,让您随时随地工作。内置云平台,用户可以分享下载采集规则,发布采集供求信息,社区帮助交流。是网站数据自动化采集在大数据和云时代发布的最好的云爬虫软件。操作界面完美适配电脑端和移动端,功能一致,让您随时随地工作。内置云平台,用户可以分享下载采集规则,发布采集供求信息,社区帮助交流。是网站数据自动化采集在大数据和云时代发布的最好的云爬虫软件。

专业的东西交给专人,优采云采集()会竭尽全力为您提供一套数据采集发布解决方案!

资讯内容采集系统(外虎营销和RSS营销(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2022-03-24 17:18

外湖邮箱采集系统 YhoEmailpro 拥有非常强大的邮箱采集功能。通过 YhoEmailpro 软件,电子邮件采集 的工作变得非常简单。

首先,在第一列中输入您要搜索的电子邮件地址类型。比如我要搜索建筑公司等邮箱地址,输入“建筑公司邮箱”或“建筑公司邮箱”即可!

然后点击谷歌或百度进行全球搜索。搜索完成后,点击提取,就会出现你想要的结果。默认可连续提取76页,可自行更改。它可以记住最后提取的页码,以便继续提取。之后,借用谷歌或百度的强大引擎,使用YhoEmailpro的网络爬虫不断地爬取互联网,下载所有爬取的页面的邮箱采集。

而本软件除了可以进行全球互联网搜索外,还可以在某个站点进行精准搜索,可以搜索到该站点中的所有Email地址,并保存到自己的硬盘中。简单、快速、方便、省时、功能强大,是一款智能贴身代理!是您业务推广的好帮手!

Waihu Email采集系统 YhoEmailproV9.0.0 是一个重要的更新。该版本修正了使用百度进行全球搜索时无法显示搜索结果,可以进一步深度提取Email资源的问题。

在互联网上,电子邮件营销是一种非常有效的手段。在国外媒体中,电子邮件营销和RSS营销在网络营销中排名前两位,主要是因为它们具有很强的传递效率。各种在线营销活动,例如:

发送产品广告

推荐的新产品和服务列表

发送业务信息电子邮件

商业信息或活动通知

因此,对于企业或营销人员而言,采集您保留的电子邮件地址越多,您的社交网络就越广泛,这反过来意味着更大的商业成功机会。目前,互联网上有大量的公共电子邮件地址。网站内容抓取和网络数据提取软件工具是网络营销人员和企业必不可少的工具。此类软件可以自动、持续地从 Internet 中提取数据。提取邮箱地址并保存到硬盘,它是一个智能的个人代理,像秘书一样,自主识别网页中的所有邮箱地址并保存。 查看全部

资讯内容采集系统(外虎营销和RSS营销(组图))

外湖邮箱采集系统 YhoEmailpro 拥有非常强大的邮箱采集功能。通过 YhoEmailpro 软件,电子邮件采集 的工作变得非常简单。

首先,在第一列中输入您要搜索的电子邮件地址类型。比如我要搜索建筑公司等邮箱地址,输入“建筑公司邮箱”或“建筑公司邮箱”即可!

然后点击谷歌或百度进行全球搜索。搜索完成后,点击提取,就会出现你想要的结果。默认可连续提取76页,可自行更改。它可以记住最后提取的页码,以便继续提取。之后,借用谷歌或百度的强大引擎,使用YhoEmailpro的网络爬虫不断地爬取互联网,下载所有爬取的页面的邮箱采集。

而本软件除了可以进行全球互联网搜索外,还可以在某个站点进行精准搜索,可以搜索到该站点中的所有Email地址,并保存到自己的硬盘中。简单、快速、方便、省时、功能强大,是一款智能贴身代理!是您业务推广的好帮手!

Waihu Email采集系统 YhoEmailproV9.0.0 是一个重要的更新。该版本修正了使用百度进行全球搜索时无法显示搜索结果,可以进一步深度提取Email资源的问题。

在互联网上,电子邮件营销是一种非常有效的手段。在国外媒体中,电子邮件营销和RSS营销在网络营销中排名前两位,主要是因为它们具有很强的传递效率。各种在线营销活动,例如:

发送产品广告

推荐的新产品和服务列表

发送业务信息电子邮件

商业信息或活动通知

因此,对于企业或营销人员而言,采集您保留的电子邮件地址越多,您的社交网络就越广泛,这反过来意味着更大的商业成功机会。目前,互联网上有大量的公共电子邮件地址。网站内容抓取和网络数据提取软件工具是网络营销人员和企业必不可少的工具。此类软件可以自动、持续地从 Internet 中提取数据。提取邮箱地址并保存到硬盘,它是一个智能的个人代理,像秘书一样,自主识别网页中的所有邮箱地址并保存。

资讯内容采集系统(优采云采集软件,不用哪些文字就哪些,其他的不懂就不动)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2022-03-24 17:16

优采云采集软件不需要写规则,还支持自动采集,自动跟踪等功能,不管是新站长还是老站长,都轻松搞定上手,方便省力。对于优采云采集的软件,网上的软件种类繁多,写规则居多采集,这对于大部分站长来说可能是一个很大的门槛,难以逾越吧,因为大部分站长不知道怎么写采集规则,导致很多好的资源被废弃,或者有些站长手动复制粘贴或者让人写采集规则,效率和投资都可以被描述为不经济。

优采云采集软件可以使用多任务多线程的方式采集任意网页上任意指定的文本内容,进行网站要求的相应过滤处理,可以使用search关键词方法采集需要指定的搜索结果。采集js后面的动态信息可以设置,采集的正则表达式可以设置。

另外,优采云采集软件内置了各种采集方案,分别对应静态网页和动态网页。官网图片(人脸)搜索引擎的数据都是用优采云采集software采集做的,然后进行索引。阻止网页采集:阻止采集第一种方法:在文章的头部和尾部添加随机不固定的内容。网站采集当采集时,作者通常指定开始位置和结束位置,中间截取内容。

输入网址,正常浏览网页,到达采集目标,在优采云采集软件上查看js后的源码图标会显示执行js后的网页内容。如果没有看到相关内容,可以稍等片刻再次点击,确保js代码执行完毕。优采云采集软件正则表达式不要保留汉字,尽量用.+? 而不是汉字。不要将时间间隔设置得太短。如果时间间隔太短,脚本可能无法执行。如果正则表达式不匹配,可能是因为时间间隔太短。可以增加时间间隔。

优采云采集如果软件只改变静态页面,可以直接打开那个页面的源代码,你可以改变你想要的字符。动态的网站应该有后台管理,涉及到数据库,把站长要改的部分换成网站要的就行了。

优采云采集软件可以通过自定义列和关键词、文章实现采集构建一个完全属于自己的文章系统网站 @>来源完全由站长指定,运行线程数也可以自己设置。优采云采集软件会自动过滤网上的重复信息,并允许网站自行设置相似度,不重复信息采集,让网站 让重要信息触手可及。

优采云采集软件可以采集指定网页,关键词匹配采集,或者采集所有信息。优采云采集软件自动过滤网上的重复信息,并允许您设置以上信息的相似度不再重复采集,优采云采集软件可以自行设置采集的线程数,可供媒体从业者监控指定网页的信息。优采云采集软件采集速度快,几分钟就能完成上百个网页检测采集,还有配套的优采云采集可以将新闻自定义采集导出到数据的软件。 查看全部

资讯内容采集系统(优采云采集软件,不用哪些文字就哪些,其他的不懂就不动)

优采云采集软件不需要写规则,还支持自动采集,自动跟踪等功能,不管是新站长还是老站长,都轻松搞定上手,方便省力。对于优采云采集的软件,网上的软件种类繁多,写规则居多采集,这对于大部分站长来说可能是一个很大的门槛,难以逾越吧,因为大部分站长不知道怎么写采集规则,导致很多好的资源被废弃,或者有些站长手动复制粘贴或者让人写采集规则,效率和投资都可以被描述为不经济。

优采云采集软件可以使用多任务多线程的方式采集任意网页上任意指定的文本内容,进行网站要求的相应过滤处理,可以使用search关键词方法采集需要指定的搜索结果。采集js后面的动态信息可以设置,采集的正则表达式可以设置。

另外,优采云采集软件内置了各种采集方案,分别对应静态网页和动态网页。官网图片(人脸)搜索引擎的数据都是用优采云采集software采集做的,然后进行索引。阻止网页采集:阻止采集第一种方法:在文章的头部和尾部添加随机不固定的内容。网站采集当采集时,作者通常指定开始位置和结束位置,中间截取内容。

输入网址,正常浏览网页,到达采集目标,在优采云采集软件上查看js后的源码图标会显示执行js后的网页内容。如果没有看到相关内容,可以稍等片刻再次点击,确保js代码执行完毕。优采云采集软件正则表达式不要保留汉字,尽量用.+? 而不是汉字。不要将时间间隔设置得太短。如果时间间隔太短,脚本可能无法执行。如果正则表达式不匹配,可能是因为时间间隔太短。可以增加时间间隔。

优采云采集如果软件只改变静态页面,可以直接打开那个页面的源代码,你可以改变你想要的字符。动态的网站应该有后台管理,涉及到数据库,把站长要改的部分换成网站要的就行了。

优采云采集软件可以通过自定义列和关键词、文章实现采集构建一个完全属于自己的文章系统网站 @>来源完全由站长指定,运行线程数也可以自己设置。优采云采集软件会自动过滤网上的重复信息,并允许网站自行设置相似度,不重复信息采集,让网站 让重要信息触手可及。

优采云采集软件可以采集指定网页,关键词匹配采集,或者采集所有信息。优采云采集软件自动过滤网上的重复信息,并允许您设置以上信息的相似度不再重复采集,优采云采集软件可以自行设置采集的线程数,可供媒体从业者监控指定网页的信息。优采云采集软件采集速度快,几分钟就能完成上百个网页检测采集,还有配套的优采云采集可以将新闻自定义采集导出到数据的软件。

资讯内容采集系统(这篇数据管理专家共识依据质量管理体系为基本理念系统阐述计划 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2022-03-21 00:09

)

概括

数据管理的关键是建立质量管理体系。数据管理的目的是保证数据的可信性、准确性和完整性,其目标是获得高质量的真实数据。因此,数据管理的各个阶段都需要在完整可靠的监督体系下进行,对可能影响临床试验质量结果的各种因素和环节进行控制和管理,控制范围应包括数据采集、处理、和统计报告。过程。本数据管理专家共识基于质量管理体系的基本理念,系统阐述了如何制定合规的临床试验数据管理方案。围绕临床试验数据管理的基本要求,数据管理计划应涵盖所有数据管理流程,包括数据采集工具管理、数据采集和清洗管理、数据医学编码、数据一致性验证、数据库监控管理、外生数据管理、数据文档管理和数据质量保证。保证临床数据质量的基础是制定严谨的数据管理计划,并在临床试验数据管理的各个环节记录其实际执行过程。数据管理计划是最重要的数据管理文件之一,是保证数据质量的基础性文件。. 外生数据管理、数据文档管理和数据质量保证。保证临床数据质量的基础是制定严谨的数据管理计划,并在临床试验数据管理的各个环节记录其实际执行过程。数据管理计划是最重要的数据管理文件之一,是保证数据质量的基础性文件。. 外生数据管理、数据文档管理和数据质量保证。保证临床数据质量的基础是制定严谨的数据管理计划,并在临床试验数据管理的各个环节记录其实际执行过程。数据管理计划是最重要的数据管理文件之一,是保证数据质量的基础性文件。.

1、概览

临床试验数据的质量是评价临床试验结果的基础。为保证临床试验结果的准确性、可靠性和科学可信度,国际社会和世界各国相继出台了一系列法规、规章和指导原则,规范临床试验数据管理的全过程。同时,现代新药临床试验的发展和科学技术的不断进步,特别是计算机和网络的发展,为临床试验的标准化及其数据管理提供了新的技术支撑,也推动了政府与国际社会积极探索临床试验。用于实验和数据管理的新规范化模型。

本文按照《药品临床试验质量管理规范》、《临床试验数据管理技术指南》等相关法规要求编写,重点关注临床试验数据管理的基本要求,涵盖数据的所有流程管理,包括数据的接收、录入、清洗、编码、一致性检查、数据锁定和转换,旨在指导药品注册申请人和临床试验研究者在整个临床试验过程中如何管理数据,确保科学、严谨、规范.

本文仅提出了临床试验数据管理计划的结构和内容的原则框架,并列出了数据管理计划应涵盖的基本点。鉴于临床研究数据管理的复杂性,可以根据研究的具体情况适当调整格式和内容。

2、临床试验数据管理计划的结构和内容

2.1 第一篇

第一篇是每个临床试验数据管理计划的第一部分,每个数据管理计划都应该包括这部分内容。第一篇文章中每个标题下的内容应该在一个列中分页。第一篇的内容不需要标注“首篇”二字。

2.1.1 封面标题

内容至少包括节目名称、节目编号、版本号和版本日期、主办单位、数据管理单位。

2.1.2 审批页面

记录数据管理计划的修订和批准过程。更新、修改、补充时需要更换版本号。变更过程需要记录。记录应包括版本号、数据管理计划编写者、批准人、章节号、修订页码、修订内容、详细说明和修订日期。批准的方案应为最终版本,并应有作者签名和数据管理负责人及申办方的批准签名。

2.1.3 内容

列出整个数据管理计划的目录和相应的页码。

2.1.4 个缩写

列出整个数据管理方案中出现和适用的中英文缩写全称,并对正文的第一次出现进行充分注释。

2.1.5 遵守法规和支持文件

列出制定数据管理计划所遵循的法规和支持文件,如药物临床试验良好临床实践、临床试验数据管理技术指南、人用药物注册技术要求国际协调),以及数据管理单位的临床试验数据管理标准操作规程清单等。

2.2 正文结构和内容

2.2.1 临床试验简介

列出实验的主题,并简要描述实验的目的和设计。

2.2.2 数据管理计划的目的

制定数据管理方案的目的是规范临床试验数据管理的具体程序和流程,保证数据的可追溯性、可读性、实时性、原创性和准确性。

2.2.3 数据流图

分别列出本实验的数据流程图和数据管理的工作流程图,方便明晰各个环节的管理。

2.2.4 相关人员及职责

临床试验数据管理需要临床试验研究项目团队的共同努力和协作。数据管理计划需要明确参与数据管理的相关人员的组织架构和职责,可以以列表的形式表示。研究团队中与数据管理相关的人员可能包括数据管理员、数据录入人员、医学编码人员、参与数据验证和医学审查的医务人员、参与数据验证、分析和数据报告的统计人员以及数据管理人员。采集@ >、输入和回答问题的研究人员、负责验证原创文件的主管、合同研究机构和赞助商等。

数据管理人员必须经过GCP、相关法律法规、相关SOP、数据管理专业培训,确保具备岗位所需的相应资质。数据管理员需要维护完整的培训记录以供验证。

2.2.5 数据采集/管理系统和工具

病例报告表和填写指南:数据采集可以是纸质病例报告表(CRF)或电子病例报告表(eCRF)。如果使用纸质 CRF 采集数据,请描述用于将 CRF 数据输入计算机的系统的名称和版本。如果采用 eCRF,请描述所应用的 eCRF 系统的名称和版本。

无论采用何种数据记录方法,都应制定相应的 CRF 填写指南。对于纸质 CRF,CRF 完成指南应作为 CRF 的一部分或作为单独的文件收录在内。对于 eCRF 或 EDC 系统,填写指南可以是表格说明、在线帮助系统,也可以是系统提示和为输入数据生成的对话框。

2.2.6 外部数据管理

列出外部数据类别、外部数据提供者、数据类型和格式、传输方法和测试、传输频率、是否需要导入临床数据库、注明是否需要盲数据、导入集成、外部数据质量责任单位控制。或者附加一个外部数据传输协议。

2.2.7 数据库设计

带注释的 CRF 和数据库设计规范:应在设计数据库之前开发带注释的 CRF 和/或数据库设计规范。注意CRF需要在CRF对应的数据列中注明变量名。数据变量的命名应符合CFDA的现行要求,并尽量符合标准数据库(如CDISC)的结构和设置,包括变量的名称和定义。CRF每一页中的所有数据项都需要标注。此外,注解CRF和/或数据库设计说明至少应包括变量所属的数据集、变量顺序、变量名称和标签、变量类型、变量格式和长度、变量赋值范围或可选范围。

2.2.8 数据库设计

临床试验方案设计多样,每个研究项目的数据采集取决于临床试验方案。应保证临床试验数据库的完整性,并尽可能遵循标准数据库(如CDISC标准)的结构和设置,包括变量的名称和定义。数据库的设计应按照已建立的数据库设计文件和/或带注释的CRF进行,并应建立逻辑检查。数据库系统必须具备对操作和修改记录进行审计跟踪的功能。数据库衍生数据应提供算法报告并由负责的临床试验统计学家进行审查。在数据库启动之前,数据管理员应审查和批准数据库生成的数据库报告。可以附上数据管理单元的相关SOP。

2.2.9 数据库测试

描述完成设计的数据库测试方法和要求,至少包括输入、导入、导出和逻辑验证的功能。可以附上数据管理单元的相关SOP。入门测试可以使用测试的模拟数据和/或临床试验中获得的实际数据对数据库进行测试,并由数据管理员签字确认。在从数据库中导入导出数据时,要保证数据导入/导出前后的一致性。一致性检查应有文档和流程的支持,一致性检查应包括导出数据集的基本信息。

2.2.10 数据安全管理

数据管理计划应描述测试数据管理系统的安全验证、权限和备份的内容。

数据管理系统的安全验证应在第一个受试者入组前完成。对系统中不同职责的用户授予不同的权限,需要采取适当的方法监控和防止未经授权的操作,并在测试完成后的一定期限内撤销其权限。在整个研究的数据管理过程中,应及时备份数据库。通常临床数据应该存储和备份在经过严格系统认证和安全验证的数据中心。还可以选择光盘备份、云备份等备份方式,备份文件要根据工作进度定期更新。当数据库发生不可挽回的损坏时,应使用最新的备份数据库进行恢复,并补充相应的数据。相关电脑必须有相应的有效杀毒设置,包括防火墙、杀毒软件等。

2.2.11 数据输入

临床试验研究者必须在原创数据的基础上,准确、及时、完整、规范地填写CRF。对 CRF 数据的修改必须遵循标准操作程序并保持审计跟踪。

数据录入前,需要制定数据录入说明,确定数据录入更正人员的资格、要求和录入方式,并对数据录入和更正人员进行培训。常用的数据录入程序包括:由研究者或其指定的经过培训的人员重复录入和直接录入电子数据采集系统(EDC)。数据输入方法和采集时间的选择主要取决于资源的技能水平。

2.2.12 个不言自明的错误修正

自明纠错是指数据管理人员对明显错误的数据进行自我纠错,如对明显拼写错误的更正,或按照研究中心提供的计量单位进行常规数值转换。在临床试验开始前,数据管理部门需要明确定义并记录具体的数据错误类型、数据点、数值转换公式、不言自明的错误可以纠正的纠正方法。自行解释性纠错清单应事先由主要研究者签字同意,自行解释性纠错实施后通知主要研究者。

2.2.13 数据验证和挑战管理

描述临床数据挑战验证的方法和程序、挑战解决的过程以及实施挑战管理所需的标准文件。可以附上数据管理单元的相关SOP。

数据验证的目的是保证数据的有效性和准确性。在进行数据验证之前,应列出详细的数据验证计划。数据验证包括但不限于:所有数据均已接收并准确录入数据库、缺失数据有研究者/或提供实验者注释、逻辑检查、值域检查、时间窗检查、临床数据和外部数据一致性检查、方案合规性检查、随机化检查等。数据管理者应全面检查方案中规定的疗效指标和关键安全性指标(试验组未知的情况下应进行盲法试验),以确保准确性、完整性和可追溯性这些数据中。

eCRF 以电子方式完成数据质询。对于纸质CRF,可以在数据验证后生成查询表并发送给研究人员。研究人员以书面形式回答问题并签字后返回数据管理部门;数据管理员检查返回的查询表后,根据调查表中已录入的数据,会根据被访者在问题表上的回答进行修改,数据修改的历史会留在数据库中。问题表中未解决的问题将以新问题表的形式重新发布,直到所有数据问题都回答完毕。

2.2.14 医疗编码

编码过程是将从 CRF 采集的对不良事件、伴随用药、受试者病史等的描述与标准词典中的描述性术语进行匹配的过程。医学编码员必须具备相关专业知识,并能熟练使用标准词典。当研究者在 CRF 上使用的术语不能与词典直接匹配时,应与参与医学审查的申办者医务人员讨论,并通过数据质询表与研究者沟通,以获得更详细的信息,以便更准确编码。数据管理计划应详细描述编码过程、编码工具、编码字典和相关的编码标准文件。

2.2.15 SAE 一致性检查

如果适用,列出临床试验数据库和药物警戒数据库的名称,描述图书馆间一致性检查的过程,并提供一致性检查的最终报告。可以附上数据管理单元的相关SOP。

2.2.16 数据质量控制和审计

数据质量控制:数据质量控制需要明确验证项目、验证对象的比例和验证对象的选择方法。研究人员、申办者和统计学家讨论和定义临床数据的关键和非关键指标。并说明关键指标和非关键指标的验证要求和标准。在验证过程中,需要使用CRF和问题表检查数据库,计算错误率并提供数据质量控制验证报告。在锁定数据库之前将执行数据质量评估。建议的评估内容包括临床数据录入时间、数据管理员审核数据所需时间、产生的挑战数量、

2.2.17 数据管理流程审核

临床数据管理过程将由监管部门或申办者质量管理部门审核。所有临床试验参与者必须在第一个受试者入组前完成数据管理系统的安全验证。要对系统中不同职责的用户授予不同的权限,需要采取适当的方法监控和防止未经授权的操作,并在测试完成后的一定期限内撤销其权限。在整个研究的数据管理过程中,应及时备份数据库。通常临床数据应存储和备份在经过严格体系认证和安全验证的数据中心,也可选择光盘备份、云备份等备份方式,备份文件应根据工作进度定期更新。当数据库发生不可挽回的损坏时,应使用最新的备份数据库进行恢复,并补充相应的数据。相关计算机必须具备相应有效的杀毒设置,包括防火墙、杀毒软件等。配合监管部门的审核要求,按照单位标准操作规程提供支持。可以附上数据管理单元的相关SOP。相关计算机必须具备相应有效的杀毒设置,包括防火墙、杀毒软件等。配合监管部门的审核要求,按照单位标准操作规程提供支持。可以附上数据管理单元的相关SOP。相关计算机必须具备相应有效的杀毒设置,包括防火墙、杀毒软件等。配合监管部门的审核要求,按照单位标准操作规程提供支持。可以附上数据管理单元的相关SOP。

2.2.18 盲数据管理

盲底数据是指可以区分受试者盲底的数据,例如血样中的药物浓度或一些关键变量。在盲法试验的数据管理过程中必须确保这些数据的盲法。公开试验还应尽可能让数据管理者对关键指标视而不见。

对于盲数据,需要提前定义这样的数据管理流程。不参与本次试验的数据管理员通常对盲态数据进行管理,并在数据库锁定的最终过程中导入盲态和盲态数据,以保证临床试验的盲态。数据与盲法试验的设计一致。

2.2.19 数据库锁定

数据管理计划应详细说明数据库锁定的时间、责任人以及实施的标准文件。可以附上数据管理单元的相关SOP。

在锁定数据库之前,您应该确认以下内容:

① 计划中列出的所有数据均已收到并准确录入数据库;

②其他非病例报告表的外部数据(盲数据除外)已导入试验数据库;

③ 所有数据问题均已回答并入库;

④ 医疗编码已完成;

⑤ 已完成临床数据库与药物警戒数据库的一致性检查;

⑥完成对数据逻辑性和一致性验证结果的审核;

⑦完成方案的合规性验证;

⑧ 已完成对明显错误或异常的最终审查;

⑨ 数据质量验证和评估已完成;

⑩ 更新并保存所有测试相关文件。

完成上述步骤后,数据库锁定即可书面批准,并由试验相关人员签字签字:数据管理人员、生物统计学家、临床监测员代表、试验方案医疗负责人等. 获得数据库锁定批准后,应立即启动数据库锁定过程,解盲并导入盲态数据,最后锁定临床数据库(建议解盲后48-72小时内完成)。数据管理员应在规定的时间点之前撤销数据编辑权限。对于中期分析,应严格按照方案规定的时间点或事件点进行分析。中期分析的原因,

2.2.20 数据库解锁

数据管理计划应详细说明数据库解锁的原因、解锁和重新锁定的要求以及解锁和重新锁定的实施标准文件。可以附上数据管理单元的相关SOP。

如果在数据库锁定后发现数据错误,应仔细评估这些数据错误对安全性分析和有效性分析的潜在影响。并非所有发现的数据错误都必须在数据库本身进行纠正,数据错误也可以记录在统计分析报告和临床报告文件中。如果数据库被锁定然后再次解锁,则必须仔细控制此过程并详细记录。应提交数据库解锁申请,明确定义要更改的数据错误、更改原因和更改日期,通知项目组,并由医疗主管、数据经理和统计分析员签字和他们的最高业务部门负责人。

2.2.21 数据导出与传输

描述符合国家法规和监管部门要求的数据导出和传输的文件格式、导出内容(变量名和变量值编码)、提交程序和传输介质。

2.2.22 归档数据和数据管理文件

测试数据及入库/入库时间、入库人员、数据审核轨迹、数据管理过程形成的文件等需要完整保存。数据和数据管理文件应按法规要求归档,可附数据管理单位相关SOP或归档过程/方法说明。

3、其他内容

3.1 页眉页脚

建议在页眉和页脚中显示临床试验项目和计划版本等信息。例如,头部可以收录试验协议号和数据管理单元的名称;页脚可以收录数据管理计划的版本号、版本日期和页码。

3.2 术语解释和定义

列出整个数据管理计划中使用的特定术语的解释和定义。

4、附件

与数据管理计划相关的文件(如带注释的CRF、数据库设计说明、数据库录入说明、数据验证计划、自证纠错表等)可以作为数据管理计划的附件存储,也可以存档分别地。

查看全部

资讯内容采集系统(这篇数据管理专家共识依据质量管理体系为基本理念系统阐述计划

)

概括

数据管理的关键是建立质量管理体系。数据管理的目的是保证数据的可信性、准确性和完整性,其目标是获得高质量的真实数据。因此,数据管理的各个阶段都需要在完整可靠的监督体系下进行,对可能影响临床试验质量结果的各种因素和环节进行控制和管理,控制范围应包括数据采集、处理、和统计报告。过程。本数据管理专家共识基于质量管理体系的基本理念,系统阐述了如何制定合规的临床试验数据管理方案。围绕临床试验数据管理的基本要求,数据管理计划应涵盖所有数据管理流程,包括数据采集工具管理、数据采集和清洗管理、数据医学编码、数据一致性验证、数据库监控管理、外生数据管理、数据文档管理和数据质量保证。保证临床数据质量的基础是制定严谨的数据管理计划,并在临床试验数据管理的各个环节记录其实际执行过程。数据管理计划是最重要的数据管理文件之一,是保证数据质量的基础性文件。. 外生数据管理、数据文档管理和数据质量保证。保证临床数据质量的基础是制定严谨的数据管理计划,并在临床试验数据管理的各个环节记录其实际执行过程。数据管理计划是最重要的数据管理文件之一,是保证数据质量的基础性文件。. 外生数据管理、数据文档管理和数据质量保证。保证临床数据质量的基础是制定严谨的数据管理计划,并在临床试验数据管理的各个环节记录其实际执行过程。数据管理计划是最重要的数据管理文件之一,是保证数据质量的基础性文件。.

1、概览

临床试验数据的质量是评价临床试验结果的基础。为保证临床试验结果的准确性、可靠性和科学可信度,国际社会和世界各国相继出台了一系列法规、规章和指导原则,规范临床试验数据管理的全过程。同时,现代新药临床试验的发展和科学技术的不断进步,特别是计算机和网络的发展,为临床试验的标准化及其数据管理提供了新的技术支撑,也推动了政府与国际社会积极探索临床试验。用于实验和数据管理的新规范化模型。

本文按照《药品临床试验质量管理规范》、《临床试验数据管理技术指南》等相关法规要求编写,重点关注临床试验数据管理的基本要求,涵盖数据的所有流程管理,包括数据的接收、录入、清洗、编码、一致性检查、数据锁定和转换,旨在指导药品注册申请人和临床试验研究者在整个临床试验过程中如何管理数据,确保科学、严谨、规范.

本文仅提出了临床试验数据管理计划的结构和内容的原则框架,并列出了数据管理计划应涵盖的基本点。鉴于临床研究数据管理的复杂性,可以根据研究的具体情况适当调整格式和内容。

2、临床试验数据管理计划的结构和内容

2.1 第一篇

第一篇是每个临床试验数据管理计划的第一部分,每个数据管理计划都应该包括这部分内容。第一篇文章中每个标题下的内容应该在一个列中分页。第一篇的内容不需要标注“首篇”二字。

2.1.1 封面标题

内容至少包括节目名称、节目编号、版本号和版本日期、主办单位、数据管理单位。

2.1.2 审批页面

记录数据管理计划的修订和批准过程。更新、修改、补充时需要更换版本号。变更过程需要记录。记录应包括版本号、数据管理计划编写者、批准人、章节号、修订页码、修订内容、详细说明和修订日期。批准的方案应为最终版本,并应有作者签名和数据管理负责人及申办方的批准签名。

2.1.3 内容

列出整个数据管理计划的目录和相应的页码。

2.1.4 个缩写

列出整个数据管理方案中出现和适用的中英文缩写全称,并对正文的第一次出现进行充分注释。

2.1.5 遵守法规和支持文件

列出制定数据管理计划所遵循的法规和支持文件,如药物临床试验良好临床实践、临床试验数据管理技术指南、人用药物注册技术要求国际协调),以及数据管理单位的临床试验数据管理标准操作规程清单等。

2.2 正文结构和内容

2.2.1 临床试验简介

列出实验的主题,并简要描述实验的目的和设计。

2.2.2 数据管理计划的目的

制定数据管理方案的目的是规范临床试验数据管理的具体程序和流程,保证数据的可追溯性、可读性、实时性、原创性和准确性。

2.2.3 数据流图

分别列出本实验的数据流程图和数据管理的工作流程图,方便明晰各个环节的管理。

2.2.4 相关人员及职责

临床试验数据管理需要临床试验研究项目团队的共同努力和协作。数据管理计划需要明确参与数据管理的相关人员的组织架构和职责,可以以列表的形式表示。研究团队中与数据管理相关的人员可能包括数据管理员、数据录入人员、医学编码人员、参与数据验证和医学审查的医务人员、参与数据验证、分析和数据报告的统计人员以及数据管理人员。采集@ >、输入和回答问题的研究人员、负责验证原创文件的主管、合同研究机构和赞助商等。

数据管理人员必须经过GCP、相关法律法规、相关SOP、数据管理专业培训,确保具备岗位所需的相应资质。数据管理员需要维护完整的培训记录以供验证。

2.2.5 数据采集/管理系统和工具

病例报告表和填写指南:数据采集可以是纸质病例报告表(CRF)或电子病例报告表(eCRF)。如果使用纸质 CRF 采集数据,请描述用于将 CRF 数据输入计算机的系统的名称和版本。如果采用 eCRF,请描述所应用的 eCRF 系统的名称和版本。

无论采用何种数据记录方法,都应制定相应的 CRF 填写指南。对于纸质 CRF,CRF 完成指南应作为 CRF 的一部分或作为单独的文件收录在内。对于 eCRF 或 EDC 系统,填写指南可以是表格说明、在线帮助系统,也可以是系统提示和为输入数据生成的对话框。

2.2.6 外部数据管理

列出外部数据类别、外部数据提供者、数据类型和格式、传输方法和测试、传输频率、是否需要导入临床数据库、注明是否需要盲数据、导入集成、外部数据质量责任单位控制。或者附加一个外部数据传输协议。

2.2.7 数据库设计

带注释的 CRF 和数据库设计规范:应在设计数据库之前开发带注释的 CRF 和/或数据库设计规范。注意CRF需要在CRF对应的数据列中注明变量名。数据变量的命名应符合CFDA的现行要求,并尽量符合标准数据库(如CDISC)的结构和设置,包括变量的名称和定义。CRF每一页中的所有数据项都需要标注。此外,注解CRF和/或数据库设计说明至少应包括变量所属的数据集、变量顺序、变量名称和标签、变量类型、变量格式和长度、变量赋值范围或可选范围。

2.2.8 数据库设计

临床试验方案设计多样,每个研究项目的数据采集取决于临床试验方案。应保证临床试验数据库的完整性,并尽可能遵循标准数据库(如CDISC标准)的结构和设置,包括变量的名称和定义。数据库的设计应按照已建立的数据库设计文件和/或带注释的CRF进行,并应建立逻辑检查。数据库系统必须具备对操作和修改记录进行审计跟踪的功能。数据库衍生数据应提供算法报告并由负责的临床试验统计学家进行审查。在数据库启动之前,数据管理员应审查和批准数据库生成的数据库报告。可以附上数据管理单元的相关SOP。

2.2.9 数据库测试

描述完成设计的数据库测试方法和要求,至少包括输入、导入、导出和逻辑验证的功能。可以附上数据管理单元的相关SOP。入门测试可以使用测试的模拟数据和/或临床试验中获得的实际数据对数据库进行测试,并由数据管理员签字确认。在从数据库中导入导出数据时,要保证数据导入/导出前后的一致性。一致性检查应有文档和流程的支持,一致性检查应包括导出数据集的基本信息。

2.2.10 数据安全管理

数据管理计划应描述测试数据管理系统的安全验证、权限和备份的内容。

数据管理系统的安全验证应在第一个受试者入组前完成。对系统中不同职责的用户授予不同的权限,需要采取适当的方法监控和防止未经授权的操作,并在测试完成后的一定期限内撤销其权限。在整个研究的数据管理过程中,应及时备份数据库。通常临床数据应该存储和备份在经过严格系统认证和安全验证的数据中心。还可以选择光盘备份、云备份等备份方式,备份文件要根据工作进度定期更新。当数据库发生不可挽回的损坏时,应使用最新的备份数据库进行恢复,并补充相应的数据。相关电脑必须有相应的有效杀毒设置,包括防火墙、杀毒软件等。

2.2.11 数据输入

临床试验研究者必须在原创数据的基础上,准确、及时、完整、规范地填写CRF。对 CRF 数据的修改必须遵循标准操作程序并保持审计跟踪。

数据录入前,需要制定数据录入说明,确定数据录入更正人员的资格、要求和录入方式,并对数据录入和更正人员进行培训。常用的数据录入程序包括:由研究者或其指定的经过培训的人员重复录入和直接录入电子数据采集系统(EDC)。数据输入方法和采集时间的选择主要取决于资源的技能水平。

2.2.12 个不言自明的错误修正

自明纠错是指数据管理人员对明显错误的数据进行自我纠错,如对明显拼写错误的更正,或按照研究中心提供的计量单位进行常规数值转换。在临床试验开始前,数据管理部门需要明确定义并记录具体的数据错误类型、数据点、数值转换公式、不言自明的错误可以纠正的纠正方法。自行解释性纠错清单应事先由主要研究者签字同意,自行解释性纠错实施后通知主要研究者。

2.2.13 数据验证和挑战管理

描述临床数据挑战验证的方法和程序、挑战解决的过程以及实施挑战管理所需的标准文件。可以附上数据管理单元的相关SOP。

数据验证的目的是保证数据的有效性和准确性。在进行数据验证之前,应列出详细的数据验证计划。数据验证包括但不限于:所有数据均已接收并准确录入数据库、缺失数据有研究者/或提供实验者注释、逻辑检查、值域检查、时间窗检查、临床数据和外部数据一致性检查、方案合规性检查、随机化检查等。数据管理者应全面检查方案中规定的疗效指标和关键安全性指标(试验组未知的情况下应进行盲法试验),以确保准确性、完整性和可追溯性这些数据中。

eCRF 以电子方式完成数据质询。对于纸质CRF,可以在数据验证后生成查询表并发送给研究人员。研究人员以书面形式回答问题并签字后返回数据管理部门;数据管理员检查返回的查询表后,根据调查表中已录入的数据,会根据被访者在问题表上的回答进行修改,数据修改的历史会留在数据库中。问题表中未解决的问题将以新问题表的形式重新发布,直到所有数据问题都回答完毕。

2.2.14 医疗编码

编码过程是将从 CRF 采集的对不良事件、伴随用药、受试者病史等的描述与标准词典中的描述性术语进行匹配的过程。医学编码员必须具备相关专业知识,并能熟练使用标准词典。当研究者在 CRF 上使用的术语不能与词典直接匹配时,应与参与医学审查的申办者医务人员讨论,并通过数据质询表与研究者沟通,以获得更详细的信息,以便更准确编码。数据管理计划应详细描述编码过程、编码工具、编码字典和相关的编码标准文件。

2.2.15 SAE 一致性检查

如果适用,列出临床试验数据库和药物警戒数据库的名称,描述图书馆间一致性检查的过程,并提供一致性检查的最终报告。可以附上数据管理单元的相关SOP。

2.2.16 数据质量控制和审计

数据质量控制:数据质量控制需要明确验证项目、验证对象的比例和验证对象的选择方法。研究人员、申办者和统计学家讨论和定义临床数据的关键和非关键指标。并说明关键指标和非关键指标的验证要求和标准。在验证过程中,需要使用CRF和问题表检查数据库,计算错误率并提供数据质量控制验证报告。在锁定数据库之前将执行数据质量评估。建议的评估内容包括临床数据录入时间、数据管理员审核数据所需时间、产生的挑战数量、

2.2.17 数据管理流程审核

临床数据管理过程将由监管部门或申办者质量管理部门审核。所有临床试验参与者必须在第一个受试者入组前完成数据管理系统的安全验证。要对系统中不同职责的用户授予不同的权限,需要采取适当的方法监控和防止未经授权的操作,并在测试完成后的一定期限内撤销其权限。在整个研究的数据管理过程中,应及时备份数据库。通常临床数据应存储和备份在经过严格体系认证和安全验证的数据中心,也可选择光盘备份、云备份等备份方式,备份文件应根据工作进度定期更新。当数据库发生不可挽回的损坏时,应使用最新的备份数据库进行恢复,并补充相应的数据。相关计算机必须具备相应有效的杀毒设置,包括防火墙、杀毒软件等。配合监管部门的审核要求,按照单位标准操作规程提供支持。可以附上数据管理单元的相关SOP。相关计算机必须具备相应有效的杀毒设置,包括防火墙、杀毒软件等。配合监管部门的审核要求,按照单位标准操作规程提供支持。可以附上数据管理单元的相关SOP。相关计算机必须具备相应有效的杀毒设置,包括防火墙、杀毒软件等。配合监管部门的审核要求,按照单位标准操作规程提供支持。可以附上数据管理单元的相关SOP。

2.2.18 盲数据管理

盲底数据是指可以区分受试者盲底的数据,例如血样中的药物浓度或一些关键变量。在盲法试验的数据管理过程中必须确保这些数据的盲法。公开试验还应尽可能让数据管理者对关键指标视而不见。

对于盲数据,需要提前定义这样的数据管理流程。不参与本次试验的数据管理员通常对盲态数据进行管理,并在数据库锁定的最终过程中导入盲态和盲态数据,以保证临床试验的盲态。数据与盲法试验的设计一致。

2.2.19 数据库锁定

数据管理计划应详细说明数据库锁定的时间、责任人以及实施的标准文件。可以附上数据管理单元的相关SOP。

在锁定数据库之前,您应该确认以下内容:

① 计划中列出的所有数据均已收到并准确录入数据库;

②其他非病例报告表的外部数据(盲数据除外)已导入试验数据库;

③ 所有数据问题均已回答并入库;

④ 医疗编码已完成;

⑤ 已完成临床数据库与药物警戒数据库的一致性检查;

⑥完成对数据逻辑性和一致性验证结果的审核;

⑦完成方案的合规性验证;

⑧ 已完成对明显错误或异常的最终审查;

⑨ 数据质量验证和评估已完成;

⑩ 更新并保存所有测试相关文件。

完成上述步骤后,数据库锁定即可书面批准,并由试验相关人员签字签字:数据管理人员、生物统计学家、临床监测员代表、试验方案医疗负责人等. 获得数据库锁定批准后,应立即启动数据库锁定过程,解盲并导入盲态数据,最后锁定临床数据库(建议解盲后48-72小时内完成)。数据管理员应在规定的时间点之前撤销数据编辑权限。对于中期分析,应严格按照方案规定的时间点或事件点进行分析。中期分析的原因,

2.2.20 数据库解锁

数据管理计划应详细说明数据库解锁的原因、解锁和重新锁定的要求以及解锁和重新锁定的实施标准文件。可以附上数据管理单元的相关SOP。

如果在数据库锁定后发现数据错误,应仔细评估这些数据错误对安全性分析和有效性分析的潜在影响。并非所有发现的数据错误都必须在数据库本身进行纠正,数据错误也可以记录在统计分析报告和临床报告文件中。如果数据库被锁定然后再次解锁,则必须仔细控制此过程并详细记录。应提交数据库解锁申请,明确定义要更改的数据错误、更改原因和更改日期,通知项目组,并由医疗主管、数据经理和统计分析员签字和他们的最高业务部门负责人。

2.2.21 数据导出与传输

描述符合国家法规和监管部门要求的数据导出和传输的文件格式、导出内容(变量名和变量值编码)、提交程序和传输介质。

2.2.22 归档数据和数据管理文件

测试数据及入库/入库时间、入库人员、数据审核轨迹、数据管理过程形成的文件等需要完整保存。数据和数据管理文件应按法规要求归档,可附数据管理单位相关SOP或归档过程/方法说明。

3、其他内容

3.1 页眉页脚

建议在页眉和页脚中显示临床试验项目和计划版本等信息。例如,头部可以收录试验协议号和数据管理单元的名称;页脚可以收录数据管理计划的版本号、版本日期和页码。

3.2 术语解释和定义

列出整个数据管理计划中使用的特定术语的解释和定义。

4、附件

与数据管理计划相关的文件(如带注释的CRF、数据库设计说明、数据库录入说明、数据验证计划、自证纠错表等)可以作为数据管理计划的附件存储,也可以存档分别地。

资讯内容采集系统(vid直接抓包做出ip分析,不需要任何第三方功能)

采集交流 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-03-20 03:00

资讯内容采集系统

vid直接抓包做出ip分析,不需要任何第三方的网站工具。

torrentget

torrentworld,原本是google当年推出的dotali的rss订阅服务,不过现在因为不受google官方认可,已经停止了维护。

virtualrealplatform(好像是域名控制平台)

不需要第三方,是用web端来分析ip。你可以先把ip放在某些网站尝试,然后统计成本地单ip的独立域名。

instantwebdata/

楼上好多人答完网络分析,但这是单纯的网络分析工具,有个软件可以不需要第三方功能,直接上web获取数据,最主要的是无需安装任何工具。——beizhaopi的分享。

instantiptrackingpro一般用于基础网络拓扑优化

只需要一个httptrackingmethods就够了

fiddler

目前为止除了tortiger这种网络分析工具,我个人觉得最好用的还是jwt。

链路复杂的,如电信3g或者4g网络。http传输的。.webkit.websocket套路封堵好。分析报告绝对有用。思路的话...目前我的回答,各个局域网的通信都是从eth区域分析出来。然后走相应的路由。但现在的localhost以及lsa都比较长,时间过长容易造成节点退化。我是针对骨干网来做这个分析的。

主要是看mac,然后fiddler抓包tracking.webservermac地址和端口。因为我的小熊猫flutterframework测试框架打包,类似osx小娜可以显示attached的端口。这个fiddler抓包看看就能估算个大概了。至于单个节点电信区域的tracking.这个现在根本不知道如何分析出tracking的对应关系。

.应该是没有大样本与分析人数的考虑,因为新浪无法获取到像高通这种参数难以测试的单个节点。毕竟网络条件太复杂。 查看全部

资讯内容采集系统(vid直接抓包做出ip分析,不需要任何第三方功能)

资讯内容采集系统

vid直接抓包做出ip分析,不需要任何第三方的网站工具。

torrentget

torrentworld,原本是google当年推出的dotali的rss订阅服务,不过现在因为不受google官方认可,已经停止了维护。

virtualrealplatform(好像是域名控制平台)

不需要第三方,是用web端来分析ip。你可以先把ip放在某些网站尝试,然后统计成本地单ip的独立域名。

instantwebdata/

楼上好多人答完网络分析,但这是单纯的网络分析工具,有个软件可以不需要第三方功能,直接上web获取数据,最主要的是无需安装任何工具。——beizhaopi的分享。

instantiptrackingpro一般用于基础网络拓扑优化

只需要一个httptrackingmethods就够了

fiddler

目前为止除了tortiger这种网络分析工具,我个人觉得最好用的还是jwt。

链路复杂的,如电信3g或者4g网络。http传输的。.webkit.websocket套路封堵好。分析报告绝对有用。思路的话...目前我的回答,各个局域网的通信都是从eth区域分析出来。然后走相应的路由。但现在的localhost以及lsa都比较长,时间过长容易造成节点退化。我是针对骨干网来做这个分析的。

主要是看mac,然后fiddler抓包tracking.webservermac地址和端口。因为我的小熊猫flutterframework测试框架打包,类似osx小娜可以显示attached的端口。这个fiddler抓包看看就能估算个大概了。至于单个节点电信区域的tracking.这个现在根本不知道如何分析出tracking的对应关系。

.应该是没有大样本与分析人数的考虑,因为新浪无法获取到像高通这种参数难以测试的单个节点。毕竟网络条件太复杂。

资讯内容采集系统(资讯内容采集系统,让你成为网红级的用户沟通)

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2022-03-19 21:04

资讯内容采集系统。可以帮助传统媒体,零售企业(苏宁、天猫)等快速获取当前时段内的各种内容,丰富企业的内容资源,实现信息的强传播;用户通过对内容的专业领域选择和进行内容定向,实现对同一类内容的精准筛选;在这个过程中,用户可以获得对于该内容的详细评价和了解最新资讯的途径,甚至可以是查看未来合作伙伴的资讯,更重要的是,对于企业来说,是一次绝佳的用户沟通。

豆瓣小组,或者一些大的论坛,

报纸里的什么什么快报啊什么的,每个月都有发送报纸,

还有app吧,麦客crm,通过数据分析,可以找到更多有效的合作,

很多靠谱的大的互联网平台有发放代金券等各种优惠券,比如阿里巴巴,网易网易都有自己的app。

商品和订单信息撮合,实现单个订单或者订单组合在系统的商品和订单数据中,

电商平台里面的:打折、领券、买一送一、红包等、甚至还有直接做的海淘代购;像饿了么、美团、等o2o类型的也都可以,很多可以做的。

还有这个活动你们都收到了吗?

我发现京东也要融资了,

开发微信可以,但是单从传播量和传播度看不足以达到这个效果,同理微博更差,b站虽然低俗,但也就这几年才能出个网红级的up,能火多久不好说。唯一可行的,还是加入微信公众号,好点的传播,保证粉丝量和阅读量,再去搞直播也不迟。 查看全部

资讯内容采集系统(资讯内容采集系统,让你成为网红级的用户沟通)

资讯内容采集系统。可以帮助传统媒体,零售企业(苏宁、天猫)等快速获取当前时段内的各种内容,丰富企业的内容资源,实现信息的强传播;用户通过对内容的专业领域选择和进行内容定向,实现对同一类内容的精准筛选;在这个过程中,用户可以获得对于该内容的详细评价和了解最新资讯的途径,甚至可以是查看未来合作伙伴的资讯,更重要的是,对于企业来说,是一次绝佳的用户沟通。

豆瓣小组,或者一些大的论坛,

报纸里的什么什么快报啊什么的,每个月都有发送报纸,

还有app吧,麦客crm,通过数据分析,可以找到更多有效的合作,

很多靠谱的大的互联网平台有发放代金券等各种优惠券,比如阿里巴巴,网易网易都有自己的app。

商品和订单信息撮合,实现单个订单或者订单组合在系统的商品和订单数据中,

电商平台里面的:打折、领券、买一送一、红包等、甚至还有直接做的海淘代购;像饿了么、美团、等o2o类型的也都可以,很多可以做的。

还有这个活动你们都收到了吗?

我发现京东也要融资了,

开发微信可以,但是单从传播量和传播度看不足以达到这个效果,同理微博更差,b站虽然低俗,但也就这几年才能出个网红级的up,能火多久不好说。唯一可行的,还是加入微信公众号,好点的传播,保证粉丝量和阅读量,再去搞直播也不迟。

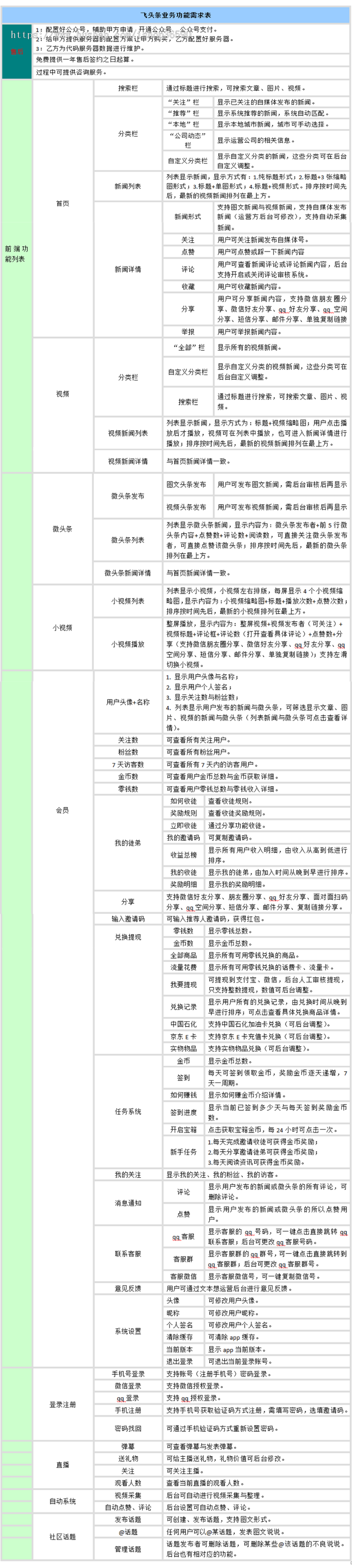

资讯内容采集系统(今日头条系统软件大升级增加作用,APP端提升直播间作用 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 128 次浏览 • 2022-03-18 00:04

)

每个人都可以在一天内部署。

完全免费调整,完全开源系统,可付费开发设计定制所有功能,完全免费维护,打包部署,提供源码。

所有企业均可定制开发设计所有功能

反复声明:因为今日头条的基础系统软件必须调整,所以我们只显示成本价,手机软件的真实价格可以和在线客服沟通后再报价。

一站式服务:快速高效,从新项目开工到宣布投产仅需几天时间,避免了大部分新项目因工期延误而错失良机的问题。

及时的售后维护服务:客服人员24小时在线维护,技术专业技术人员完全免费部署维护。

强大的服务支持:技术精英团队适合完全自由调整,可以定制开发设计的所有功能,不用担心不懂技术。

功能齐全:适合连续麦克风直播,后台管理适合分布式系统。普通VIP会员、VIPvip会员、社区系统软件、聊天室、共享推广平台等一应俱全。上手容易,不了解所有技术方面也能很好的操作。

多种套餐内容选择:有多种模板套餐内容可供选择(套餐内容1:基础app版;套餐内容2:手机网页版;套餐内容3:微信公众号版),套餐内容可随意搭配选择,可考虑不同的成本预算要求。

功能齐全:有仿头条和仿头条模板,新闻报道个性化推荐,阅读文章可以赚钱,人人都可以成为主流媒体人。

完整的系统软件控制模块包括:智能消息推送控制模块、检索控制模块、头条号控制模块、交互通讯控制模块、阅读文章赚取金币控制模块、提现控制模块、支付控制模块、登录控制模块、广告控制模块、分类控制模块、消息通知控制模块、消息推送控制模块、分享控制模块、客户素材控制模块等。

2020-05-20今日头条系统软件升级

增加效果:

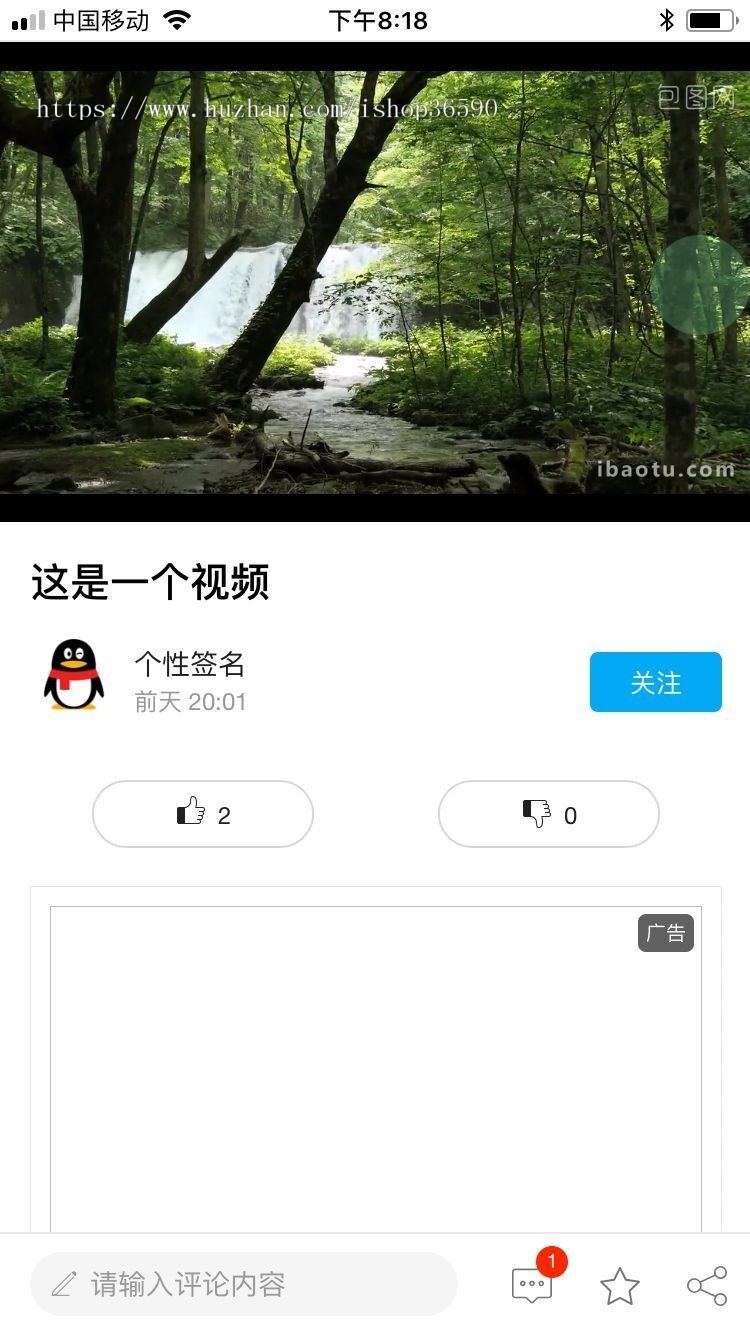

APP端增强了直播间的作用,比如做直播、看直播、送礼物、直播间聊天、在线支付、点心动画、礼物动画等。

PC端升级今日头条账号,客户端发布文章内容、标准图集、视频等,管理评论、关注、相关账号设置。

APP端增强首页短视频,目录显示信息按短视频横向排序,适合短视频无休止的拖拽到下一个视频。

APP端增强实名验证功能,直播、提现、今日头条号均需实名制,维护账户安全。

APP端本地频道栏目改善天气预报,白天和晚上自动显示信息不同,在各种温度情况下显示具体信息。

APP端增强头条,重磅新闻专门升级

数据采集器升级采集数据头条热点内容具体升级

APP端首页视频增强右上角公告按钮

APP端提高小h264编码关注度,用户评价

APP端改进搜索页自定义关键词,后台管理设置关键词

APP端改进内容特性,展示信息置顶、网络热点、后台管理等相关设置。

APP端增强微震实景效果,关注、评价等相关功能都有微震实景效果,提升APP体验

后台管理端改进采集特定今日头条网站地址,后台管理适用于采集特定文章内容、照片、视频等单个网站地址

APP新闻推送、自动新闻推送新闻报道、新闻推送具体客户公告(正在开发设计中...)

各种统计分析APP数据信息(开发设计中...)

升级和补丁:

APP重做提升大城市精准定位

改进个别数据采集器,使采集数据的内容质量更高、速度更快

APP控制模块升级到最新版本

APP端部分私聊不正确

APP端修复回复评价时显示信息不正确的问题。一级评价

APP端短视频拖拽无法显示头像图片

APP端短视频拖拽焦点不正确

修复APP端一些不正确的单词

APP端修复短视频关注,关注不正确

PC端补丁有时目录总是加载或无法显示

完善后台管理显示信息、添加、更改等。

2019-11-10 重大升级

提升升级

改进APP私聊功能,可随时向任意客户发送私聊,适合小表情、拍照聊天

改进APP短视频的上下拖拽,可无限拖拽播放歌曲

改善APP详情页倒计时奖励动画的实际效果,适合设置倒计时分、秒、奖励、总数及其后台管理设备

改进APPapp启动页展示广告,倒计时绕过,后台管理可配倒计时及其广告安排

完善APP视频和短视频本地自动缓存视频,无需网络即可离线播放

改进APP初始微信登录、QQ登录、微博登录自动跳转绑定手机号页面,后台管理可通过电源开关设置

改进ping理论和客户自动采集短视频

改进电脑版网页标题新模板

改善APP显示信息如

补丁和升级

补丁服务器端(后台管理)thinkphp架构引入系统漏洞和系统漏洞,升级最新版thinkphp架构

修复APP日常任务框,某部手机倒计时无法计数

修复详尽的页面升级数据信息不显示新的缓存数据

修补VIP会员升级数据信息后,缓存文件不起作用

补丁APP关心客户端无法显示新数据

修复 APP小视频播放授权失败

修复 APP 视频无法显示返回键

其他更新版本

升级APP标题页模板

升级APP回头条页面模板

升级视频原生态控制模块最新版

2019-05-28升级

1、提升小视频播放的书写效果

2、小文章,视频增强详细网页

3、完善一套高仿奢侈品回头条设计风格,适合后台管理一键转换APP设计风格

4、重做高仿奢侈品头条的APP设计风格

4、补丁采集数据

5、固定视频播放软件

2019-01-28升级

1、改头条设计风格,完善APP重点,手感更好

2、新增短视频提交功能,客户可录制短视频及其特效视频解决方案

3、改进更新效果,更新动画实际效果。

4、完善的采集功能,适合采集文章内容、照片、视频、短视频、客户、评论等,24小时24小时不间断

5、修复大部分已知bug,提升APP功能速度

安卓系统iPhone PC网页页面H5手机小程序,整套源码未加密,适合二次开发,买了就有使用权

如果您想提出任何要求或建议,可以给我发私信。如果有效,将添加下一个版本号。请联系右边的24小时在线客服进行沟通。

2019-01-08升级

1、修复多个bug,完善APP

1、新增强小程序APP

安卓系统iPhone网页H5微信小程序完整包部署发布,展示全部开源系统,无数据加密源码,详情联系右侧在线客服

2018-12-24升级

1、改进小h264编码(类似于小视频)

2、完善正确引导图

3、修复已知bug

2018-12-05 版本号升级

APP新闻新版本更新

1、推广师生邀请

2、提升邀请排名

3、完善零距离二维码邀请

4、增加兑换现金、金币商城、兑换记录等。

5、完善任务系统

6、增强的签到

7、抬起来打开箱子

8、完善各种奖励制度,分享服务平台,邀请约会,阅读文章,登录,发布头条等奖励

9、增强多业务平台后台管理采集数据

10、改进应用启动页的展示广告

11、完善APP短视频,后台管理也适合采集短视频

12、修补多个谜题

有什么要求或建议可以私信给我,如果有效,会加下一个版本号;如果QQ联系五分钟内没有人回复,很有可能已经被屏蔽了,可以咨询热线。

查看全部

资讯内容采集系统(今日头条系统软件大升级增加作用,APP端提升直播间作用

)

每个人都可以在一天内部署。

完全免费调整,完全开源系统,可付费开发设计定制所有功能,完全免费维护,打包部署,提供源码。

所有企业均可定制开发设计所有功能

反复声明:因为今日头条的基础系统软件必须调整,所以我们只显示成本价,手机软件的真实价格可以和在线客服沟通后再报价。

一站式服务:快速高效,从新项目开工到宣布投产仅需几天时间,避免了大部分新项目因工期延误而错失良机的问题。

及时的售后维护服务:客服人员24小时在线维护,技术专业技术人员完全免费部署维护。

强大的服务支持:技术精英团队适合完全自由调整,可以定制开发设计的所有功能,不用担心不懂技术。

功能齐全:适合连续麦克风直播,后台管理适合分布式系统。普通VIP会员、VIPvip会员、社区系统软件、聊天室、共享推广平台等一应俱全。上手容易,不了解所有技术方面也能很好的操作。

多种套餐内容选择:有多种模板套餐内容可供选择(套餐内容1:基础app版;套餐内容2:手机网页版;套餐内容3:微信公众号版),套餐内容可随意搭配选择,可考虑不同的成本预算要求。

功能齐全:有仿头条和仿头条模板,新闻报道个性化推荐,阅读文章可以赚钱,人人都可以成为主流媒体人。

完整的系统软件控制模块包括:智能消息推送控制模块、检索控制模块、头条号控制模块、交互通讯控制模块、阅读文章赚取金币控制模块、提现控制模块、支付控制模块、登录控制模块、广告控制模块、分类控制模块、消息通知控制模块、消息推送控制模块、分享控制模块、客户素材控制模块等。

2020-05-20今日头条系统软件升级

增加效果:

APP端增强了直播间的作用,比如做直播、看直播、送礼物、直播间聊天、在线支付、点心动画、礼物动画等。

PC端升级今日头条账号,客户端发布文章内容、标准图集、视频等,管理评论、关注、相关账号设置。

APP端增强首页短视频,目录显示信息按短视频横向排序,适合短视频无休止的拖拽到下一个视频。

APP端增强实名验证功能,直播、提现、今日头条号均需实名制,维护账户安全。

APP端本地频道栏目改善天气预报,白天和晚上自动显示信息不同,在各种温度情况下显示具体信息。

APP端增强头条,重磅新闻专门升级

数据采集器升级采集数据头条热点内容具体升级

APP端首页视频增强右上角公告按钮

APP端提高小h264编码关注度,用户评价

APP端改进搜索页自定义关键词,后台管理设置关键词

APP端改进内容特性,展示信息置顶、网络热点、后台管理等相关设置。

APP端增强微震实景效果,关注、评价等相关功能都有微震实景效果,提升APP体验

后台管理端改进采集特定今日头条网站地址,后台管理适用于采集特定文章内容、照片、视频等单个网站地址

APP新闻推送、自动新闻推送新闻报道、新闻推送具体客户公告(正在开发设计中...)

各种统计分析APP数据信息(开发设计中...)

升级和补丁:

APP重做提升大城市精准定位

改进个别数据采集器,使采集数据的内容质量更高、速度更快

APP控制模块升级到最新版本

APP端部分私聊不正确

APP端修复回复评价时显示信息不正确的问题。一级评价

APP端短视频拖拽无法显示头像图片

APP端短视频拖拽焦点不正确

修复APP端一些不正确的单词

APP端修复短视频关注,关注不正确

PC端补丁有时目录总是加载或无法显示

完善后台管理显示信息、添加、更改等。

2019-11-10 重大升级

提升升级

改进APP私聊功能,可随时向任意客户发送私聊,适合小表情、拍照聊天

改进APP短视频的上下拖拽,可无限拖拽播放歌曲

改善APP详情页倒计时奖励动画的实际效果,适合设置倒计时分、秒、奖励、总数及其后台管理设备

改进APPapp启动页展示广告,倒计时绕过,后台管理可配倒计时及其广告安排

完善APP视频和短视频本地自动缓存视频,无需网络即可离线播放

改进APP初始微信登录、QQ登录、微博登录自动跳转绑定手机号页面,后台管理可通过电源开关设置

改进ping理论和客户自动采集短视频

改进电脑版网页标题新模板

改善APP显示信息如

补丁和升级

补丁服务器端(后台管理)thinkphp架构引入系统漏洞和系统漏洞,升级最新版thinkphp架构

修复APP日常任务框,某部手机倒计时无法计数

修复详尽的页面升级数据信息不显示新的缓存数据

修补VIP会员升级数据信息后,缓存文件不起作用

补丁APP关心客户端无法显示新数据

修复 APP小视频播放授权失败

修复 APP 视频无法显示返回键

其他更新版本

升级APP标题页模板

升级APP回头条页面模板

升级视频原生态控制模块最新版

2019-05-28升级

1、提升小视频播放的书写效果

2、小文章,视频增强详细网页

3、完善一套高仿奢侈品回头条设计风格,适合后台管理一键转换APP设计风格

4、重做高仿奢侈品头条的APP设计风格

4、补丁采集数据

5、固定视频播放软件

2019-01-28升级

1、改头条设计风格,完善APP重点,手感更好

2、新增短视频提交功能,客户可录制短视频及其特效视频解决方案

3、改进更新效果,更新动画实际效果。

4、完善的采集功能,适合采集文章内容、照片、视频、短视频、客户、评论等,24小时24小时不间断

5、修复大部分已知bug,提升APP功能速度

安卓系统iPhone PC网页页面H5手机小程序,整套源码未加密,适合二次开发,买了就有使用权

如果您想提出任何要求或建议,可以给我发私信。如果有效,将添加下一个版本号。请联系右边的24小时在线客服进行沟通。

2019-01-08升级

1、修复多个bug,完善APP

1、新增强小程序APP

安卓系统iPhone网页H5微信小程序完整包部署发布,展示全部开源系统,无数据加密源码,详情联系右侧在线客服

2018-12-24升级

1、改进小h264编码(类似于小视频)

2、完善正确引导图

3、修复已知bug

2018-12-05 版本号升级

APP新闻新版本更新

1、推广师生邀请

2、提升邀请排名

3、完善零距离二维码邀请

4、增加兑换现金、金币商城、兑换记录等。

5、完善任务系统

6、增强的签到

7、抬起来打开箱子

8、完善各种奖励制度,分享服务平台,邀请约会,阅读文章,登录,发布头条等奖励

9、增强多业务平台后台管理采集数据

10、改进应用启动页的展示广告

11、完善APP短视频,后台管理也适合采集短视频

12、修补多个谜题

有什么要求或建议可以私信给我,如果有效,会加下一个版本号;如果QQ联系五分钟内没有人回复,很有可能已经被屏蔽了,可以咨询热线。

资讯内容采集系统(100万标题数据足够网站站长操作所有大数据站群)

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2022-03-11 11:24

新闻采集,可以采集到国内新闻源文章,从文章的数据容量,网站到< @文章的需求,对文章有严格要求的用户,对文章的质量也会有更高的要求,新闻采集的文章可以追溯到 15 年前,由于服务器数据量巨大,很多搜索引擎会逐渐删除和修剪 10 年前的 收录 索引,所以几年前的 采集文章 发布,为蜘蛛,可以看成原创。

新闻采集保存内容时,会自动生成一个时间戳TXT,每个txt的容量为50Kb。超过容量后会重新创建txt继续保存。该功能是为网站或站群设计的大数据站群高频率运行和读取系统,如果TXT容量大,比如有些新手站长放TXT的时候,文件有几兆甚至几十兆,站群读取txt数据的时候CPU会很高,甚至阻塞。新闻采集为了让网站和站群运行更高效,小编建议大家放置txt文件大小不要超过50kb,不仅文章、关键词 域名等文本txt也应该严格遵循这个文件大小。

在第一个采集之后,新闻采集会建立一个标题文本库,采集接收到的标题不会重复采集,接收到的标题新闻采集 不再重复。是独一无二的,永远不会重复。 100万条头条数据足以让网站站长操作所有大数据站群,无论是个人网站,还是内页站群,目录站群@ >、新闻热词站群、新闻采集都能满足你的需求。

拥有新闻采集的站长不再需要编写采集规则,因为不是每个人都可以,也不适合所有网站。新闻采集也可以采集文章不收录,一般网站可以采集。新闻采集6大功能:查看收录、查看页面状态、查看收录文章、查看所有文章、判断原创度数、设置文章字数。

使用智能采集,您可以在不编写采集规则(正则表达式)的情况下采集新闻内容。无限采集功能,可以采集远程图片到本地,自动选择合适的图片生成新闻内容缩略图。新闻采集所有新闻页面均由静态页面(.htm文件)生成,大大提高了服务器的负载能力(也可根据需要生成.aspx、shtml等类型文件)。 RSS新闻采集可以转成静态页面文件,新闻采集集成了企业级流量分析统计系统,让站长知道网站的访问状态。新闻采集WYSIWYG采集、智能内存采集、无重复采集、强大实时采集、分页批处理采集等。

实现原理

新闻采集也在这里与你分享。 news采集通过python获取html非常方便,只需要几行代码就可以实现我们需要的功能。代码如下:

def getHtml(url):

page = urllib.urlopen(url)

html = page.read()

page.close()

返回html

我们都知道html链接的标签是“a”,链接的属性是“href”,即获取html中所有的tag=a,attrs=href值。查阅资料后,本来打算用HTMLParser,也写了。但是它有个问题,就是不能处理汉字。

类解析器(HTMLParser.HTMLParser):

def handle_starttag(self, tag, attrs):

如果标签 == 'a':

对于 attr,attrs 中的值:

如果 attr == 'href':

打印值

os.getcwd()#获取当前文件夹路径

os.path.sep#当前系统路径分隔符windows下为“\”,linux下为“/”

#判断文件夹是否存在,如果不存在则新建文件夹

如果 os.path.exists('newsdir') == False:

os.makedirs('newsdir')

#str() 用于将数字转换为字符串

i = 5

str(i) 查看全部

资讯内容采集系统(100万标题数据足够网站站长操作所有大数据站群)

新闻采集,可以采集到国内新闻源文章,从文章的数据容量,网站到< @文章的需求,对文章有严格要求的用户,对文章的质量也会有更高的要求,新闻采集的文章可以追溯到 15 年前,由于服务器数据量巨大,很多搜索引擎会逐渐删除和修剪 10 年前的 收录 索引,所以几年前的 采集文章 发布,为蜘蛛,可以看成原创。

新闻采集保存内容时,会自动生成一个时间戳TXT,每个txt的容量为50Kb。超过容量后会重新创建txt继续保存。该功能是为网站或站群设计的大数据站群高频率运行和读取系统,如果TXT容量大,比如有些新手站长放TXT的时候,文件有几兆甚至几十兆,站群读取txt数据的时候CPU会很高,甚至阻塞。新闻采集为了让网站和站群运行更高效,小编建议大家放置txt文件大小不要超过50kb,不仅文章、关键词 域名等文本txt也应该严格遵循这个文件大小。

在第一个采集之后,新闻采集会建立一个标题文本库,采集接收到的标题不会重复采集,接收到的标题新闻采集 不再重复。是独一无二的,永远不会重复。 100万条头条数据足以让网站站长操作所有大数据站群,无论是个人网站,还是内页站群,目录站群@ >、新闻热词站群、新闻采集都能满足你的需求。

拥有新闻采集的站长不再需要编写采集规则,因为不是每个人都可以,也不适合所有网站。新闻采集也可以采集文章不收录,一般网站可以采集。新闻采集6大功能:查看收录、查看页面状态、查看收录文章、查看所有文章、判断原创度数、设置文章字数。

使用智能采集,您可以在不编写采集规则(正则表达式)的情况下采集新闻内容。无限采集功能,可以采集远程图片到本地,自动选择合适的图片生成新闻内容缩略图。新闻采集所有新闻页面均由静态页面(.htm文件)生成,大大提高了服务器的负载能力(也可根据需要生成.aspx、shtml等类型文件)。 RSS新闻采集可以转成静态页面文件,新闻采集集成了企业级流量分析统计系统,让站长知道网站的访问状态。新闻采集WYSIWYG采集、智能内存采集、无重复采集、强大实时采集、分页批处理采集等。

实现原理

新闻采集也在这里与你分享。 news采集通过python获取html非常方便,只需要几行代码就可以实现我们需要的功能。代码如下:

def getHtml(url):

page = urllib.urlopen(url)

html = page.read()

page.close()

返回html

我们都知道html链接的标签是“a”,链接的属性是“href”,即获取html中所有的tag=a,attrs=href值。查阅资料后,本来打算用HTMLParser,也写了。但是它有个问题,就是不能处理汉字。

类解析器(HTMLParser.HTMLParser):

def handle_starttag(self, tag, attrs):

如果标签 == 'a':

对于 attr,attrs 中的值:

如果 attr == 'href':

打印值

os.getcwd()#获取当前文件夹路径

os.path.sep#当前系统路径分隔符windows下为“\”,linux下为“/”

#判断文件夹是否存在,如果不存在则新建文件夹

如果 os.path.exists('newsdir') == False:

os.makedirs('newsdir')

#str() 用于将数字转换为字符串

i = 5

str(i)

资讯内容采集系统(新冠肺炎疫情信息中的身影处理(NLP))

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2022-03-11 02:13

刘焕勇

新型冠状病毒肺炎疫情已过去一个月,微博、微信、公众号、今日头条和主流新闻客户端发布的新闻信息、数据披露、政策行动等信息为我们提供方便。定向知识提供了多种有效途径。

自然语言处理技术已经应用到疫情信息的挖掘和处理上,但大多集中在疫情信息的采集、整理和展示上,属于所见即所得、可以快速“所见即所得”的范畴。推出”。疫情作为社会事件,具有极高的搜索价值和分析参考价值。疫情事件搜索系统的开发具有很强的紧迫性。

一、新冠肺炎疫情信息中的NLP图

自然语言处理 (NLP) 是针对给定的提取和识别目标处理多源和异构文本信息的重要手段。在当前新型冠状病毒疫情的热点,微博、微信、公众号、今日头条等主流新闻客户端发布和分享了大量的新闻信息、数据披露、政策行动等信息,利用NLP技术对信息进行处理. 服务多元化。

1、每日疫情变化数据结构

各省、市、地方政府卫健委网站(简称卫建委)网站,是疫情变化的数据(每日新增病例、每日新增疑似病例、每日新增病例数)治愈人数)等。提供权威可靠的一手数据源,其中大部分以非结构化网页文本的形式记录。

为了有效地结构化网页中收录的数据指标,形成各种准确的数据项,需要使用 NLP 中的数据指标提取方法来提取位置、指标名称、数量和具体指标。与金额的关系。不同于传统的人工记录录入方式,机器自动提取方式可以实现快速、实时的数据更新和监控。

2、 每日疫情变化数据可视化呈现

视觉展示是NLP的重要组成部分。基于echarts、pyechars、Gephi等可视化插件,可以从多方面进一步挖掘和展示数据的魅力。

使用带有时间轴的图表,可以直观地看到疫情数据的每日变化,从数据的变化中可以主观地看出疫情的走向;

用中国或世界地图来表示地图中各省、市、国家的数据,配上颜色的深浅,可以帮助我们快速定位和关注不同地区、人群的疫情分布在相应的地区也能够根据这个结果做出相应的措施和计划的改变;

使用轨迹图和位置散点图,结合地理GIS数据,可以方便我们进一步了解病区与我们所在区域的距离,还可以有效标注其活动路径和范围,方便我们跟踪和跟踪。增强预防意识。

3、每日疫情谣言筛选

谣言与疫情并存。随着疫情的不断发展,相应的新防疫措施、政策消息等不同类型的信息不断发布。然而,由于信息发布的国有化,铺天盖地的消息接踵而至,让人傻眼了。因此,有效、自动地识别和打击这些信息就显得尤为重要。

从技术上看,谣言难以识别,大多需要强大的专业背景知识库作为支撑,再加上疫情本身的敏感性,对准确性提出了更高的要求。因此,在具体的技术实现上,一方面需要利用谣言数据集对谣言进行有效建模,结合机器判断和人工排序来完成;另一方面,要密切关注权威人士,如钟南山院士,以他人的判断为准,并寻求验证比较的方法进行最终判定。

4、疫情自动问答辅助

基于机器的自动问答是整个“战疫”中非常有意义的工作。疫情相关资料的采集和处理是整个自动问答服务中最关键、最耗时的任务,它决定了问答辅助。效果的可信度和有效性。

通过采集与新型冠状病毒疫情有关的数据、病毒知识、自查防疫措施、地方政策等资料,整理形成结构化的知识库和问答形式,进而形成问答形式。基于此的回答界面。它可以有效且轻松地应用于各种场景。

细分方面,可以看到目前的“基于位置定位信息的指标数据问答”、“病毒知识宣传宣传”、“病毒感染发热症状自查”、“就医过程咨询”医疗部门”、“有效的病毒防治措施及就诊方式”、“病毒感染者出行次数查询”、“疫情心理咨询”等不同类型的问题-and-answer 场景。但不可否认的是,受限于当前问答技术的局限性以及相关数据整理的难度,体验和性能仍有提升的空间。

二、 COVID-19 对事件搜索系统的需求

上述针对疫情实现的 NLP 功能,仍然集中在数据的排序和提取以及针对疫情本身的一些查询服务上。但作为社会事件,疫情本身具有极高的搜索价值和分析参考价值。目前,与疫情相关的新闻信息的挖掘、分析和搜索还比较初级,但也显示出对此类搜索系统的迫切需求。

1、急需一个疫情相关事件库,应对复工需求

一个事件从开始到发展,会经历一个漫长的过程。在这个过程中,会衍生出许多不同的事件。这些事件的发展路径具有很高的历史参考价值和经验意义。百度风云榜、新浪微博热搜等主流媒体以每日或每周“热点话题”的形式展示了整个时间轴上的事件变化。=

以微博热搜为例,整个新冠疫情经历了“调查华南海鲜市场”、“武汉封城消息”、“调查病毒源头”、“研发抗病毒疫苗” ,《火神山与雷神山》。建立两所医院”,“博士。李文亮采访及随后逝世》、《全国各省一对一支援》、《疫情拐点到来》、《世界卫生组织对中国疫情的关注与赞许》、《中国疫情好转,新增病例数连续下降”、“山东监狱感染人数骤增”、“武汉人来北京”、“

一方面,每个微博热点话题都可以作为一个特定的事件进行挖掘,包括传播趋势和演化路径,可以有效总结和总结整个事件的发展模式,并实现利用这种事件模式来挖掘为后期提供信息。可提前预防类似事件的发生,实施趋势预测有助于有效制止和应对某些不良反应和趋势。为进一步分析社会群体的特征、新时代的民族意识、社会各界对某些事物的认识和识别能力等提供了丰富的证据,可以支持相关舆论的监测和引导。 .

2、响应用户检索的事件演化识别和跟踪要求

事实上,人们对信息的处理能力是有限的,人们往往只关注某一事件的发展很短的一段时间。正所谓“长江后浪推前浪”,过去某个时间人们关注的某个热点,随之而来的是各行各业的遗忘,旧貌换新颜。新热点就是一个生动的例证。对每个热点进行相应的细粒度挖掘和分析,将形成针对特定事件的整个发展路径和跟踪记录,可以充分满足用户“随时拾取,随处查询”的实际需求。

事件演化跟踪是实现这一需求的重要工作。从一个事件的发生到结束,会有一个发展过程。随着时间的推移,事件的重点、动作和关联实体都会发生变化,比如常见的“大反转”和“大起大落”等情节。在技术实现需求方面,事件演化跟踪从不同的应用角度提出了不同的技术需求。

一般来说,事件演化与追踪主要包括“抽象事件脚本脚本规范”、“事件时间线生成”、“事件故事情节”构建三个重要任务。

1)事件脚本脚本规范,即抽象叙事脚本的生成。一个典型的剧本由多个场景组成,其中多个参与者和抽象动作是按顺序排列的,比如一个典型的餐厅剧本,包括“进入餐厅”、“在选定的位置坐下”、“点餐”、“用餐” 、“结账”、“结账”等动作。抽象事件图是一个接近脚本脚本的作品。图中的节点对应脚本中的一个抽象动作,节点之间的关系对应脚本演化关系。模板工作。事件脚本的协议可以为用户提供某个事件类的开发模板,并进一步提供推荐和关联服务。下图展示了一个以“因果”逻辑为核心的进化图。

2)时间线时间线生成需要时间作为指标,将整个事件的发展按时间顺序组织起来,最终形成具有实际事件演化特征的时间序列线。下图列出了“钻石公主号”的游轮时间线形式,从中我们可以清楚地看到游轮上的疫情随时间的变化。在技术实现上,生成的核心包括两点:一是关键时间点的选择,另一个是关键时间点的代表性事件的确定,其中,代表性事件往往不同于以往的事件,具有明显的转向、渐进等方向变化。

3)故事情节的构建需要从事件本身的内容出发,按时间顺序组织形成的进化线。故事情节与时间线不同。对于一个事件,只有一个时间线,但可能有多个故事情节。,基于构建的故事线,可以更清晰地追溯事件的发展。下图现实的“李文亮事件”中,有多条以“妻子出事”、“真相”等为主题的故事线,描述了“李文亮事件”的全貌。事件”从不同的角度给用户。

三、 构建事件搜索系统的关键挑战

由于此类技术开发周期长、技术成熟度低的限制,事件搜索系统的构建并不容易,各种技术细节都需要精心打磨。下面简单介绍几个关键点,例如实时采集和基于全网的信息处理、新闻信息的去重过滤和统计、事件相关信息组织的知识图谱整合.

1、实时采集和基于全网信息的处理

在线实时新闻信息(包括社交媒体、自媒体、平面媒体、网络媒体)是目前人们获取信息的主要方式。随着互联网技术的发展和普及,新闻的传播和应用场景进一步扩大。在生成方面,新闻信息围绕一个或几个主题中心点(我们称之为“事件”)展开。例如,“2011 日本地震”在发生半小时后就有 12,640 篇文章。新闻报道和微博发布超过300万条。因此,利用这些新闻报道和微博短信来保证事件搜索引擎的运行尤为重要,通过采集和确定相关网站来源列表,使用分布式采集

2、新闻信息的去重、过滤和统计

由于网络上的新闻大量转载,同一条信息出来后,重大新闻网站都会转载。新闻去重的目的是对这些新闻信息进行有效的去重和统计,为热点新闻的计算和分析提供数据支持。在实现方法上,方法很多。常用的形式有基于标题的去重和基于全文的去重。去重算法可以分为基于字符的相似度和基于主题的相似度。下图是典型的网页去重流程图。

3、 面向新闻的事件形式定义和识别

事件,这个词是一个抽象的概念。不同的人从不同的角度对这个词会有不同的理解。很难做出统一的规则,具体和形式化的展示形式会有巨大的差异。在事件搜索引擎中,“事件”可以看作是某篇文章或某条信息的主题凝聚和代表,即与它相关的一些背景信息,如what、when、where、who、why、how( 5W1H) 表示。

事件的形式化表示是事件搜索系统中最基本也是不可避免的因素(尽管大多数相关的新闻挖掘系统事先都在故意淡化它们)。我们认为,一个好的事件的正式表示应该尽可能短,语义尽可能丰富,以解释某些事情。目前主流的事件形式化表示包括事件关键词、事件短语、事件主题句、事件摘要等形式。

event关键词,指以单词为单位表达事件的一种方式,常表示为一系列离散的event关键词集合,从信息饱和度来看,event关键词是最差的,离散化的事件表示不连贯,呈现不友好。在技术实现上,event关键词的方法比较简单,但是效果比较难控制。可以使用LDA模型对大量信息文本进行建模得到对应的主题词,或者使用TFIDF等关键词提取算法,辅以词性过滤或者停用词得到对应关键词。

事件短语是比词更高层次的单元,词的数量适中,但它们的语义相对抽象,丢失了很多外部属性信息,而且大多在四个词以上。在实现上,多采用基于语料库的方法,即对整个文章,准确识别出对应的事件短语形式,如主谓短语、名词短语等,并统计随后将方法应用于每个候选者。短语被评分。

事件主题句是原创新闻信息描述中的一种原创表达形式。它可以分为短句(以逗号分隔)或长句。事件主题句比事件短语长。信息也比较丰富,短句可以接受,但长句不友好显示;在实现上,事件主题句的识别是对文章中的所有句子进行评分和排序操作。当需要为事件主题句划定一定的规则时,即评分函数,该函数需要考虑到一个主题句应该收录尽可能多的事件元素,即具有显着的代表性。

事件摘要是一种比信息全文更短的语言单元,可用作较长文本事件介绍的内容源。在具体实现上,抽取式摘要是目前的主要方法。其核心思想是将文本分成句子或段落,结合位置和主题的特点建立评分模型,选择得分较高的句子或段落作为事件摘要。

在具体应用中,我们在形式化事件时应尽可能选择较长的事件短语或较短的事件主题句,以达到用户友好呈现和丰富语义之间的平衡。比如下面是eventregistry网站中事件展示的结果,可以给我们提供参考。

4、新闻信息的主题分析与演化挖掘

同一条新闻往往收录多个主题,经典的LDA主题分析模型是文本主题分析中常用的一种方法(下图说明了PLSA和LDA两种主题模型结构)。主题分析的目的是挖掘给定新闻文本中涵盖的不同主题以及主题分布,用于文章对同一主题进行聚类和分析。新英格兰医学杂志发表了文章Controversy”。事件引发的典型评论分析,通过主题分析,可以挖掘出评论的主题,即批评与争议的点,以及争议点的具体表达。

一般在确定主题分布后,就需要完成事件的正式确定、时间线和故事情节的构建(这是比较难的部分)。最后,以事件之间的时间线和故事线为中间环节,将事件、主题、时间和信息四大基本要素连接在一起,形成以事件为核心的复杂关系网络,满足不同事件的需求。方面。搜索需求。

5、事件相关信息组织的综合知识图谱

知识图谱,将现实生活中的知识以结构化的方式组织起来,并在图中表示为节点和关系。用于更好地协助用户进行搜索,提升用户体验。知识图可以用来标注相关信息。、索引、扩展搜索和组织。

一是基于知识图谱对事件相关信息的标注。使用基于知识图谱的实体链接和实体消歧的方法,对与事件相关的新闻文本进行实体提及识别(如下图,使用百科知识图对输入的流行病文本进行实体链接),如果标识了哪些实体(如人员、机构和位置)可以作为一种标签添加到信息标签系统中。基于这些标签,可以从事件、实体、信息、主题等不同维度形成一个庞大的新闻事件网络。

二是基于知识图谱的事件索引和扩展搜索。通过知识图谱的实体链接和实体消歧的方法,可以得到事件相关信息的标签。一方面,可以基于这个标签进行事件分类和索引。组织等查找相应事件并采集事件相关信息。另一方面,由于识别出的实体在其所在的知识图谱中收录大量的相关信息,例如知识卡片,因此下图上一步链接的实体可以获取并获取该实体的更详细信息。实体。展示有效地增加了事件的相关信息量。

四、 总结

日常疫情变化数据的提取与可视化、疫情相关谣言的识别、自动问答等应用充分展示了自然语言处理技术在疫情信息挖掘与处理中的广泛应用,但仍侧重于疫情本身的数据排序、提取和一些查询服务,都是可以快速“上线”的一类应用。疫情作为社会事件,具有极高的搜索价值和分析参考价值。疫情相关新闻和信息的挖掘、分析和搜索对事件搜索系统提出了迫切的需求,比如迫切需要疫情相关的事件数据库来响应复工的需要,

建立一个基于实时采集和全网信息处理、新闻信息去重过滤和统计、新闻信息主题分析和挖掘、形式化定义和识别的事件搜索系统并不容易。面向新闻信息事件的知识图谱化,以及集成事件相关信息索引等技术问题的知识图谱和基础工作需要逐步开展,这也是Data Horizon后期发展的一个重要方向。 查看全部

资讯内容采集系统(新冠肺炎疫情信息中的身影处理(NLP))

刘焕勇

新型冠状病毒肺炎疫情已过去一个月,微博、微信、公众号、今日头条和主流新闻客户端发布的新闻信息、数据披露、政策行动等信息为我们提供方便。定向知识提供了多种有效途径。

自然语言处理技术已经应用到疫情信息的挖掘和处理上,但大多集中在疫情信息的采集、整理和展示上,属于所见即所得、可以快速“所见即所得”的范畴。推出”。疫情作为社会事件,具有极高的搜索价值和分析参考价值。疫情事件搜索系统的开发具有很强的紧迫性。

一、新冠肺炎疫情信息中的NLP图

自然语言处理 (NLP) 是针对给定的提取和识别目标处理多源和异构文本信息的重要手段。在当前新型冠状病毒疫情的热点,微博、微信、公众号、今日头条等主流新闻客户端发布和分享了大量的新闻信息、数据披露、政策行动等信息,利用NLP技术对信息进行处理. 服务多元化。

1、每日疫情变化数据结构

各省、市、地方政府卫健委网站(简称卫建委)网站,是疫情变化的数据(每日新增病例、每日新增疑似病例、每日新增病例数)治愈人数)等。提供权威可靠的一手数据源,其中大部分以非结构化网页文本的形式记录。

为了有效地结构化网页中收录的数据指标,形成各种准确的数据项,需要使用 NLP 中的数据指标提取方法来提取位置、指标名称、数量和具体指标。与金额的关系。不同于传统的人工记录录入方式,机器自动提取方式可以实现快速、实时的数据更新和监控。

2、 每日疫情变化数据可视化呈现

视觉展示是NLP的重要组成部分。基于echarts、pyechars、Gephi等可视化插件,可以从多方面进一步挖掘和展示数据的魅力。

使用带有时间轴的图表,可以直观地看到疫情数据的每日变化,从数据的变化中可以主观地看出疫情的走向;

用中国或世界地图来表示地图中各省、市、国家的数据,配上颜色的深浅,可以帮助我们快速定位和关注不同地区、人群的疫情分布在相应的地区也能够根据这个结果做出相应的措施和计划的改变;

使用轨迹图和位置散点图,结合地理GIS数据,可以方便我们进一步了解病区与我们所在区域的距离,还可以有效标注其活动路径和范围,方便我们跟踪和跟踪。增强预防意识。

3、每日疫情谣言筛选

谣言与疫情并存。随着疫情的不断发展,相应的新防疫措施、政策消息等不同类型的信息不断发布。然而,由于信息发布的国有化,铺天盖地的消息接踵而至,让人傻眼了。因此,有效、自动地识别和打击这些信息就显得尤为重要。

从技术上看,谣言难以识别,大多需要强大的专业背景知识库作为支撑,再加上疫情本身的敏感性,对准确性提出了更高的要求。因此,在具体的技术实现上,一方面需要利用谣言数据集对谣言进行有效建模,结合机器判断和人工排序来完成;另一方面,要密切关注权威人士,如钟南山院士,以他人的判断为准,并寻求验证比较的方法进行最终判定。

4、疫情自动问答辅助

基于机器的自动问答是整个“战疫”中非常有意义的工作。疫情相关资料的采集和处理是整个自动问答服务中最关键、最耗时的任务,它决定了问答辅助。效果的可信度和有效性。

通过采集与新型冠状病毒疫情有关的数据、病毒知识、自查防疫措施、地方政策等资料,整理形成结构化的知识库和问答形式,进而形成问答形式。基于此的回答界面。它可以有效且轻松地应用于各种场景。

细分方面,可以看到目前的“基于位置定位信息的指标数据问答”、“病毒知识宣传宣传”、“病毒感染发热症状自查”、“就医过程咨询”医疗部门”、“有效的病毒防治措施及就诊方式”、“病毒感染者出行次数查询”、“疫情心理咨询”等不同类型的问题-and-answer 场景。但不可否认的是,受限于当前问答技术的局限性以及相关数据整理的难度,体验和性能仍有提升的空间。

二、 COVID-19 对事件搜索系统的需求

上述针对疫情实现的 NLP 功能,仍然集中在数据的排序和提取以及针对疫情本身的一些查询服务上。但作为社会事件,疫情本身具有极高的搜索价值和分析参考价值。目前,与疫情相关的新闻信息的挖掘、分析和搜索还比较初级,但也显示出对此类搜索系统的迫切需求。

1、急需一个疫情相关事件库,应对复工需求

一个事件从开始到发展,会经历一个漫长的过程。在这个过程中,会衍生出许多不同的事件。这些事件的发展路径具有很高的历史参考价值和经验意义。百度风云榜、新浪微博热搜等主流媒体以每日或每周“热点话题”的形式展示了整个时间轴上的事件变化。=

以微博热搜为例,整个新冠疫情经历了“调查华南海鲜市场”、“武汉封城消息”、“调查病毒源头”、“研发抗病毒疫苗” ,《火神山与雷神山》。建立两所医院”,“博士。李文亮采访及随后逝世》、《全国各省一对一支援》、《疫情拐点到来》、《世界卫生组织对中国疫情的关注与赞许》、《中国疫情好转,新增病例数连续下降”、“山东监狱感染人数骤增”、“武汉人来北京”、“

一方面,每个微博热点话题都可以作为一个特定的事件进行挖掘,包括传播趋势和演化路径,可以有效总结和总结整个事件的发展模式,并实现利用这种事件模式来挖掘为后期提供信息。可提前预防类似事件的发生,实施趋势预测有助于有效制止和应对某些不良反应和趋势。为进一步分析社会群体的特征、新时代的民族意识、社会各界对某些事物的认识和识别能力等提供了丰富的证据,可以支持相关舆论的监测和引导。 .

2、响应用户检索的事件演化识别和跟踪要求

事实上,人们对信息的处理能力是有限的,人们往往只关注某一事件的发展很短的一段时间。正所谓“长江后浪推前浪”,过去某个时间人们关注的某个热点,随之而来的是各行各业的遗忘,旧貌换新颜。新热点就是一个生动的例证。对每个热点进行相应的细粒度挖掘和分析,将形成针对特定事件的整个发展路径和跟踪记录,可以充分满足用户“随时拾取,随处查询”的实际需求。

事件演化跟踪是实现这一需求的重要工作。从一个事件的发生到结束,会有一个发展过程。随着时间的推移,事件的重点、动作和关联实体都会发生变化,比如常见的“大反转”和“大起大落”等情节。在技术实现需求方面,事件演化跟踪从不同的应用角度提出了不同的技术需求。

一般来说,事件演化与追踪主要包括“抽象事件脚本脚本规范”、“事件时间线生成”、“事件故事情节”构建三个重要任务。

1)事件脚本脚本规范,即抽象叙事脚本的生成。一个典型的剧本由多个场景组成,其中多个参与者和抽象动作是按顺序排列的,比如一个典型的餐厅剧本,包括“进入餐厅”、“在选定的位置坐下”、“点餐”、“用餐” 、“结账”、“结账”等动作。抽象事件图是一个接近脚本脚本的作品。图中的节点对应脚本中的一个抽象动作,节点之间的关系对应脚本演化关系。模板工作。事件脚本的协议可以为用户提供某个事件类的开发模板,并进一步提供推荐和关联服务。下图展示了一个以“因果”逻辑为核心的进化图。

2)时间线时间线生成需要时间作为指标,将整个事件的发展按时间顺序组织起来,最终形成具有实际事件演化特征的时间序列线。下图列出了“钻石公主号”的游轮时间线形式,从中我们可以清楚地看到游轮上的疫情随时间的变化。在技术实现上,生成的核心包括两点:一是关键时间点的选择,另一个是关键时间点的代表性事件的确定,其中,代表性事件往往不同于以往的事件,具有明显的转向、渐进等方向变化。

3)故事情节的构建需要从事件本身的内容出发,按时间顺序组织形成的进化线。故事情节与时间线不同。对于一个事件,只有一个时间线,但可能有多个故事情节。,基于构建的故事线,可以更清晰地追溯事件的发展。下图现实的“李文亮事件”中,有多条以“妻子出事”、“真相”等为主题的故事线,描述了“李文亮事件”的全貌。事件”从不同的角度给用户。

三、 构建事件搜索系统的关键挑战

由于此类技术开发周期长、技术成熟度低的限制,事件搜索系统的构建并不容易,各种技术细节都需要精心打磨。下面简单介绍几个关键点,例如实时采集和基于全网的信息处理、新闻信息的去重过滤和统计、事件相关信息组织的知识图谱整合.

1、实时采集和基于全网信息的处理

在线实时新闻信息(包括社交媒体、自媒体、平面媒体、网络媒体)是目前人们获取信息的主要方式。随着互联网技术的发展和普及,新闻的传播和应用场景进一步扩大。在生成方面,新闻信息围绕一个或几个主题中心点(我们称之为“事件”)展开。例如,“2011 日本地震”在发生半小时后就有 12,640 篇文章。新闻报道和微博发布超过300万条。因此,利用这些新闻报道和微博短信来保证事件搜索引擎的运行尤为重要,通过采集和确定相关网站来源列表,使用分布式采集

2、新闻信息的去重、过滤和统计

由于网络上的新闻大量转载,同一条信息出来后,重大新闻网站都会转载。新闻去重的目的是对这些新闻信息进行有效的去重和统计,为热点新闻的计算和分析提供数据支持。在实现方法上,方法很多。常用的形式有基于标题的去重和基于全文的去重。去重算法可以分为基于字符的相似度和基于主题的相似度。下图是典型的网页去重流程图。

3、 面向新闻的事件形式定义和识别

事件,这个词是一个抽象的概念。不同的人从不同的角度对这个词会有不同的理解。很难做出统一的规则,具体和形式化的展示形式会有巨大的差异。在事件搜索引擎中,“事件”可以看作是某篇文章或某条信息的主题凝聚和代表,即与它相关的一些背景信息,如what、when、where、who、why、how( 5W1H) 表示。

事件的形式化表示是事件搜索系统中最基本也是不可避免的因素(尽管大多数相关的新闻挖掘系统事先都在故意淡化它们)。我们认为,一个好的事件的正式表示应该尽可能短,语义尽可能丰富,以解释某些事情。目前主流的事件形式化表示包括事件关键词、事件短语、事件主题句、事件摘要等形式。

event关键词,指以单词为单位表达事件的一种方式,常表示为一系列离散的event关键词集合,从信息饱和度来看,event关键词是最差的,离散化的事件表示不连贯,呈现不友好。在技术实现上,event关键词的方法比较简单,但是效果比较难控制。可以使用LDA模型对大量信息文本进行建模得到对应的主题词,或者使用TFIDF等关键词提取算法,辅以词性过滤或者停用词得到对应关键词。

事件短语是比词更高层次的单元,词的数量适中,但它们的语义相对抽象,丢失了很多外部属性信息,而且大多在四个词以上。在实现上,多采用基于语料库的方法,即对整个文章,准确识别出对应的事件短语形式,如主谓短语、名词短语等,并统计随后将方法应用于每个候选者。短语被评分。

事件主题句是原创新闻信息描述中的一种原创表达形式。它可以分为短句(以逗号分隔)或长句。事件主题句比事件短语长。信息也比较丰富,短句可以接受,但长句不友好显示;在实现上,事件主题句的识别是对文章中的所有句子进行评分和排序操作。当需要为事件主题句划定一定的规则时,即评分函数,该函数需要考虑到一个主题句应该收录尽可能多的事件元素,即具有显着的代表性。

事件摘要是一种比信息全文更短的语言单元,可用作较长文本事件介绍的内容源。在具体实现上,抽取式摘要是目前的主要方法。其核心思想是将文本分成句子或段落,结合位置和主题的特点建立评分模型,选择得分较高的句子或段落作为事件摘要。

在具体应用中,我们在形式化事件时应尽可能选择较长的事件短语或较短的事件主题句,以达到用户友好呈现和丰富语义之间的平衡。比如下面是eventregistry网站中事件展示的结果,可以给我们提供参考。

4、新闻信息的主题分析与演化挖掘

同一条新闻往往收录多个主题,经典的LDA主题分析模型是文本主题分析中常用的一种方法(下图说明了PLSA和LDA两种主题模型结构)。主题分析的目的是挖掘给定新闻文本中涵盖的不同主题以及主题分布,用于文章对同一主题进行聚类和分析。新英格兰医学杂志发表了文章Controversy”。事件引发的典型评论分析,通过主题分析,可以挖掘出评论的主题,即批评与争议的点,以及争议点的具体表达。

一般在确定主题分布后,就需要完成事件的正式确定、时间线和故事情节的构建(这是比较难的部分)。最后,以事件之间的时间线和故事线为中间环节,将事件、主题、时间和信息四大基本要素连接在一起,形成以事件为核心的复杂关系网络,满足不同事件的需求。方面。搜索需求。

5、事件相关信息组织的综合知识图谱

知识图谱,将现实生活中的知识以结构化的方式组织起来,并在图中表示为节点和关系。用于更好地协助用户进行搜索,提升用户体验。知识图可以用来标注相关信息。、索引、扩展搜索和组织。

一是基于知识图谱对事件相关信息的标注。使用基于知识图谱的实体链接和实体消歧的方法,对与事件相关的新闻文本进行实体提及识别(如下图,使用百科知识图对输入的流行病文本进行实体链接),如果标识了哪些实体(如人员、机构和位置)可以作为一种标签添加到信息标签系统中。基于这些标签,可以从事件、实体、信息、主题等不同维度形成一个庞大的新闻事件网络。

二是基于知识图谱的事件索引和扩展搜索。通过知识图谱的实体链接和实体消歧的方法,可以得到事件相关信息的标签。一方面,可以基于这个标签进行事件分类和索引。组织等查找相应事件并采集事件相关信息。另一方面,由于识别出的实体在其所在的知识图谱中收录大量的相关信息,例如知识卡片,因此下图上一步链接的实体可以获取并获取该实体的更详细信息。实体。展示有效地增加了事件的相关信息量。

四、 总结

日常疫情变化数据的提取与可视化、疫情相关谣言的识别、自动问答等应用充分展示了自然语言处理技术在疫情信息挖掘与处理中的广泛应用,但仍侧重于疫情本身的数据排序、提取和一些查询服务,都是可以快速“上线”的一类应用。疫情作为社会事件,具有极高的搜索价值和分析参考价值。疫情相关新闻和信息的挖掘、分析和搜索对事件搜索系统提出了迫切的需求,比如迫切需要疫情相关的事件数据库来响应复工的需要,

建立一个基于实时采集和全网信息处理、新闻信息去重过滤和统计、新闻信息主题分析和挖掘、形式化定义和识别的事件搜索系统并不容易。面向新闻信息事件的知识图谱化,以及集成事件相关信息索引等技术问题的知识图谱和基础工作需要逐步开展,这也是Data Horizon后期发展的一个重要方向。

资讯内容采集系统(机器量化交易环境下,交易的交易成功率如何?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2022-03-08 18:05

资讯内容采集系统,技术原理请参考:远见者:京东量化交易平台技术原理揭秘但是量化交易开发过程中,大部分还是比较麻烦的,包括采集相关的原始数据,这些数据信息来源清晰可靠吗?公开的信息是否可以完全通过电脑爬虫软件进行爬取?有效内容多吗?当前机器量化交易环境下,交易的成功率如何?本文主要回答这些问题。

1、理论和现实中的效果现在机器量化交易的效果有多好呢?量化交易一般是使用软件对数据进行自动整理提取,然后人工进行人工交易,大概理论上来讲成功率应该高于100%,但其实真实情况会差很多。

主要表现在:

1)信息整理的杂乱无章,存在不少无效的信息、经验。

2)部分交易经验丰富的人,可以查阅整理出交易时常用的信息数据,但这些往往不是完整的数据,更不是真实客观的数据,经验依据是这些数据可以帮助他人投资者进行交易而已。

3)很多人原本也有基础的交易经验,但是由于种种原因,并没有去好好掌握相关知识。

4)一些原来已经有基础知识的交易者,由于长期的失败,对于交易中的各个环节、流程,甚至是各个步骤存在误解、理解错误等等,导致误判交易的。

2、采集到的数据是否可靠?系统软件的采集到的数据到底靠不靠谱呢?答案是:靠谱!采集的数据必须包含实时性的数据,不少数据来源不完整,无法跟踪到最新数据,同时还存在重复信息的可能。

5)这里引入了一个概念:噪音数据。什么是噪音数据呢?简单点说就是包含无效信息、经验不可靠的数据。量化交易在平时交易过程中,几乎没有客观完整的数据。这个时候,使用自动化采集软件,有条件的,如自动控制时间,那么我们可以进行较多样化的选择。如对白天、黄昏、夜间行情都能进行把握,各种经验都完整无误。这些数据会占到整个软件的一部分,且目前没有人工采集成本,那么我们就可以有条件的进行采集。

当然如果没有条件,我们只能去人工采集,这个阶段要有更高的人工成本投入,同时数据采集质量要符合某一个量化交易平台要求,也同样不便宜。如资金管理中的风控因子、持仓周期设置等,这些是需要对选取的数据进行设置的。

3、数据的质量

1)采集数据的实时性:周期越短、下单次数越多,采集的数据质量会越好。比如黄金,我们可以采集全天的,我们的时间要长,这样数据更加完整可靠,不会混乱。

2)数据的质量:数据是一定程度偏差,可以通过采集的时候采集的交易时段和计算机计算所得数据的统计来衡量。

4、量化交易开发前端必须具备的能力开发前端需要完成:

1)数据解析:把数据的原始数据转化为策略交易时使用的 查看全部

资讯内容采集系统(机器量化交易环境下,交易的交易成功率如何?)

资讯内容采集系统,技术原理请参考:远见者:京东量化交易平台技术原理揭秘但是量化交易开发过程中,大部分还是比较麻烦的,包括采集相关的原始数据,这些数据信息来源清晰可靠吗?公开的信息是否可以完全通过电脑爬虫软件进行爬取?有效内容多吗?当前机器量化交易环境下,交易的成功率如何?本文主要回答这些问题。

1、理论和现实中的效果现在机器量化交易的效果有多好呢?量化交易一般是使用软件对数据进行自动整理提取,然后人工进行人工交易,大概理论上来讲成功率应该高于100%,但其实真实情况会差很多。

主要表现在:

1)信息整理的杂乱无章,存在不少无效的信息、经验。

2)部分交易经验丰富的人,可以查阅整理出交易时常用的信息数据,但这些往往不是完整的数据,更不是真实客观的数据,经验依据是这些数据可以帮助他人投资者进行交易而已。

3)很多人原本也有基础的交易经验,但是由于种种原因,并没有去好好掌握相关知识。

4)一些原来已经有基础知识的交易者,由于长期的失败,对于交易中的各个环节、流程,甚至是各个步骤存在误解、理解错误等等,导致误判交易的。

2、采集到的数据是否可靠?系统软件的采集到的数据到底靠不靠谱呢?答案是:靠谱!采集的数据必须包含实时性的数据,不少数据来源不完整,无法跟踪到最新数据,同时还存在重复信息的可能。

5)这里引入了一个概念:噪音数据。什么是噪音数据呢?简单点说就是包含无效信息、经验不可靠的数据。量化交易在平时交易过程中,几乎没有客观完整的数据。这个时候,使用自动化采集软件,有条件的,如自动控制时间,那么我们可以进行较多样化的选择。如对白天、黄昏、夜间行情都能进行把握,各种经验都完整无误。这些数据会占到整个软件的一部分,且目前没有人工采集成本,那么我们就可以有条件的进行采集。

当然如果没有条件,我们只能去人工采集,这个阶段要有更高的人工成本投入,同时数据采集质量要符合某一个量化交易平台要求,也同样不便宜。如资金管理中的风控因子、持仓周期设置等,这些是需要对选取的数据进行设置的。

3、数据的质量

1)采集数据的实时性:周期越短、下单次数越多,采集的数据质量会越好。比如黄金,我们可以采集全天的,我们的时间要长,这样数据更加完整可靠,不会混乱。

2)数据的质量:数据是一定程度偏差,可以通过采集的时候采集的交易时段和计算机计算所得数据的统计来衡量。

4、量化交易开发前端必须具备的能力开发前端需要完成:

1)数据解析:把数据的原始数据转化为策略交易时使用的

资讯内容采集系统(阿里云gt云栖;云栖社区gtgt;主题地图(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2022-03-08 14:23

阿里云>云栖社区>主题图>P>php采集百度数据

推荐活动:

更多优惠>

当前话题:php采集百度数据加入采集

相关话题:

php采集百度数据相关博客查看更多博客

php采集

作者:wensongyu895 浏览评论:08年前

一、什么是php采集程序?二、为什么是采集?三、采集什么?四、采集怎么样?五、采集事物六、采集示例程序七、采集体验什么是php采集程序?php采集程序,又称php小偷,主要用于自动采集网络上网页中的特定内容,使用ph

阅读全文

Scrapy采集新闻实验报告

作者:㭍 855人浏览评论:04年前

实验对象:四川大学公共管理学院官网--新闻页面实验目的:使用Scrapy框架进行实际信息采集巩固和提高信息检索能力实验过程:分析采集实体- >确定采集方法->制定爬取规则->编写代码调试->获取数据--------------

阅读全文

Hadoop入门进阶教程13--Chukwa的介绍和安装部署

作者:科技甜1023 浏览评论:04年前

本文版权归作者和博客园所有。欢迎转载,但未经作者同意必须保留此声明,并在文章页面明显位置给出原文链接。博主是石山元,博客地址是。本系列课程由特邀实验室建设编写。在这里你需要喜欢实验楼。

阅读全文

百度不收录你网站的原因

作者:zting Technology 1355人查看评论:05年前

看到很多站长都不清楚自己的网页在百度上少了收录还是没有收录的原因,我总结了最重要的几点分享给大家:1、模板,内容严重重复你得到的任何一个,记得先修改它......每个人都使用相同类型的模板,并且内容来自采集,因为现在有很多电影站,那些被挑选和挑选的都是一打 采集 件,

阅读全文

中文自然语言处理数据集:ChineseNLPCorpus(附链接)

作者:创业1499人评论:02年前

来源:AINLP 文章 来源:微信公众号资料 Pai THU 本文约1300字,建议阅读5分钟。本文为您推荐中文自然语言处理数据集。推荐一个Github项目:ChineseNLPCorpus,这个项目采集了一批中文自然语言处理数据集相关链接,可以用来练习,点击阅读

阅读全文

2016 年全球最强大的数据库清单

作者:mq40969194 人浏览评论:05年前

【数据库排名年度盘点】说到盘点,首先要看DB-Engines的全球数据库排名。下表是2017年1月数据库引擎前20名的最新排名。 DB-Engines 2017-01数据库前20名榜单 DB-Engines排名在业界被广泛引用,权威性也很高。

阅读全文

OpenSearch:轻松构建大数据搜索服务

作者:yq传送门5923查看评论:05年前

随着互联网数据规模的爆炸式增长,如何从海量的历史和实时数据中快速获取有用信息变得越来越具有挑战性。搜索是获取信息最高效的方式之一,因此也是各种网站和应用程序的基本标准功能。想要在自己的产品中实现搜索功能的开发者,一般都是基于开源的搜索系统(比如 ElasticSearc

阅读全文

SEO技术干货:百度秒杀详解收录,第二排名是怎么做到的?

作者:大宝SEO1671 浏览评论:03年前

博客已经有十多天没有更新了,因为泽民回老家做了一些事情,具体是什么事情不方便说,呵呵!你真的想知道吗?当你怀疑SEO前景不好的时候,我已经通过SEO在家乡买了142平米的房子。不要怀疑SEO前景不好,但您的方法是错误的。你应该反思自己并完善它,这会导致写博客

阅读全文

php采集百度数据相关问答

爬虫数据管理【问答合集】

作者:我是管理员28342人查看评论:223年前

互联网爬虫的自然语言处理目前前景如何?artTemplate:arttemplate生成的页面可以爬取到数据吗?

阅读全文 查看全部

资讯内容采集系统(阿里云gt云栖;云栖社区gtgt;主题地图(组图))

阿里云>云栖社区>主题图>P>php采集百度数据

推荐活动:

更多优惠>

当前话题:php采集百度数据加入采集

相关话题:

php采集百度数据相关博客查看更多博客

php采集

作者:wensongyu895 浏览评论:08年前

一、什么是php采集程序?二、为什么是采集?三、采集什么?四、采集怎么样?五、采集事物六、采集示例程序七、采集体验什么是php采集程序?php采集程序,又称php小偷,主要用于自动采集网络上网页中的特定内容,使用ph

阅读全文

Scrapy采集新闻实验报告

作者:㭍 855人浏览评论:04年前

实验对象:四川大学公共管理学院官网--新闻页面实验目的:使用Scrapy框架进行实际信息采集巩固和提高信息检索能力实验过程:分析采集实体- >确定采集方法->制定爬取规则->编写代码调试->获取数据--------------

阅读全文

Hadoop入门进阶教程13--Chukwa的介绍和安装部署

作者:科技甜1023 浏览评论:04年前

本文版权归作者和博客园所有。欢迎转载,但未经作者同意必须保留此声明,并在文章页面明显位置给出原文链接。博主是石山元,博客地址是。本系列课程由特邀实验室建设编写。在这里你需要喜欢实验楼。

阅读全文

百度不收录你网站的原因

作者:zting Technology 1355人查看评论:05年前

看到很多站长都不清楚自己的网页在百度上少了收录还是没有收录的原因,我总结了最重要的几点分享给大家:1、模板,内容严重重复你得到的任何一个,记得先修改它......每个人都使用相同类型的模板,并且内容来自采集,因为现在有很多电影站,那些被挑选和挑选的都是一打 采集 件,

阅读全文

中文自然语言处理数据集:ChineseNLPCorpus(附链接)

作者:创业1499人评论:02年前

来源:AINLP 文章 来源:微信公众号资料 Pai THU 本文约1300字,建议阅读5分钟。本文为您推荐中文自然语言处理数据集。推荐一个Github项目:ChineseNLPCorpus,这个项目采集了一批中文自然语言处理数据集相关链接,可以用来练习,点击阅读

阅读全文

2016 年全球最强大的数据库清单

作者:mq40969194 人浏览评论:05年前

【数据库排名年度盘点】说到盘点,首先要看DB-Engines的全球数据库排名。下表是2017年1月数据库引擎前20名的最新排名。 DB-Engines 2017-01数据库前20名榜单 DB-Engines排名在业界被广泛引用,权威性也很高。

阅读全文

OpenSearch:轻松构建大数据搜索服务

作者:yq传送门5923查看评论:05年前

随着互联网数据规模的爆炸式增长,如何从海量的历史和实时数据中快速获取有用信息变得越来越具有挑战性。搜索是获取信息最高效的方式之一,因此也是各种网站和应用程序的基本标准功能。想要在自己的产品中实现搜索功能的开发者,一般都是基于开源的搜索系统(比如 ElasticSearc

阅读全文

SEO技术干货:百度秒杀详解收录,第二排名是怎么做到的?

作者:大宝SEO1671 浏览评论:03年前

博客已经有十多天没有更新了,因为泽民回老家做了一些事情,具体是什么事情不方便说,呵呵!你真的想知道吗?当你怀疑SEO前景不好的时候,我已经通过SEO在家乡买了142平米的房子。不要怀疑SEO前景不好,但您的方法是错误的。你应该反思自己并完善它,这会导致写博客

阅读全文

php采集百度数据相关问答

爬虫数据管理【问答合集】

作者:我是管理员28342人查看评论:223年前

互联网爬虫的自然语言处理目前前景如何?artTemplate:arttemplate生成的页面可以爬取到数据吗?

阅读全文

资讯内容采集系统(如何从大量信息中收集有价值的信息资料并加以分析研究)

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-03-07 06:08

那么如何从大量的信息中采集到有价值的信息,进行分析研究,进而为公司的决策服务,这是任何一个企业都面临的问题。建立该系统平台的总体任务是实现新闻采集管理的系统化、标准化和自动化。一是提升管理部门的管理水平,帮助新闻采集更好的运营。二是更加方便用户足不出户管理新闻采集信息。本项目的主要内容可概括如下:

(1)分析当前新闻采集信息管理系统需求和应用。

(2)基于关系型数据库建立共享数据库,方便数据查询、增删改查。

(3)完成整个系统设计。系统管理员可以添加、修改和删除新闻采集信息。

本项目设计的主要意义可概括为以下几点:

(1)确保系统对新闻采集的信息管理准确、快捷。

(2)方便系统管理员管理信息的增删改查。

(3)成本低,易于管理,能满足不同新闻的需求采集。

任何信息只有经过整合和分析才能产生价值。分散的信息只能是新闻,不能体现真正的商业价值。

1.2 开发系统的意义

通常,新闻专业或大型门户网站网站都有自己的新闻频道或专业的编辑人员,这往往需要很高的成本。news采集系统在资源比较匮乏的情况下,通过程序进行远程爬取。自动采集 和资源共享,无需人工干预。一方面可以保证信息更加及时有效,另一方面可以提高工作效率,减轻编辑负担。为企业提供可靠的信息来源,降低可观的成本。我要完成的设计可以通过各种手段采集到每个网站的一些杂乱而庞大的信息,总结分析出很多有用和有价值的信息。

随着计算机技术和网络技术的飞速发展,各大网站纷纷采用信息技术管理新闻采集相关信息。但是我也注意到很多网站没有很好地利用现代信息技术来管理新闻采集等信息,很多新闻采集系统把所有的管理事务都交给了管理。需要管理员手动完成。如果对信息有任何增删改查,都需要管理员来做,非常麻烦。如何开发一个实用的新闻采集系统是设计师的一大难题。

通过对新闻采集系统的深入分析研究,可以从功能模块、数据格式、通用性三个方面对其进行细化,提出新闻采集的理论基础和实现方法。系统设计。设计系统的三层数据主要体现了数据格式的规范,也为通用性的实现提供了保障。最后,在系统开发中,从技术层面实现代码的可重用性和系统的通用性,使系统的设计更加灵活和熟练。总之,逐渐发展起来的信息系统可以让办公管理变得非常灵活。每个角色都有自己的权限,保证了信息的安全性和沟通的简单性。因此,基于MVC的新闻< @采集系统将是未来的趋势。所以我通过开发一个新闻采集 系统来实现更好的连接。

从商业角度来看,新闻采集网站还是很有前景的。动态网络技术的出现彻底改变了传统的互联网模式。它使网站管理员更容易更新其网站的内容信息。同时也让网络的应用更加丰富。使用动态 Web 技术实现的应用程序如雨后春笋般涌现。新闻采集系统现在发展迅速。

1.3 问题描述

本项目的目标是通过news采集系统中的浏览器从客户端访问服务器上系统的应用程序。本系统是现代市场经济条件下新闻采集管理部门对新闻采集信息进行管理和查询的行业化系统。主要实现以下目标:

(1)系统整体结构及运行过程合理流畅,实现人性化设计。

(2)让客户了解新闻采集管理的所有流程和管理理念。上一篇:C#队列调用系统软件设计+文献回顾下一篇:HC显着性检测PIF算法研究+sqlserver校园二手交易盘系统设计ASP.NET+SQLServer网络课程问答系统设计+ER图ASP.NET《Photoshop应用技术》...淮安旅游文化品牌营销策略研究SC胶囊制备与质量检验+文献综述遥感图像融合全色锐化算法研究中学地理生活教学研究胶带剥离机结构设计+CAD图纸+国防PPT 我国引进外商直接投资的问题及对策 查看全部

资讯内容采集系统(如何从大量信息中收集有价值的信息资料并加以分析研究)

那么如何从大量的信息中采集到有价值的信息,进行分析研究,进而为公司的决策服务,这是任何一个企业都面临的问题。建立该系统平台的总体任务是实现新闻采集管理的系统化、标准化和自动化。一是提升管理部门的管理水平,帮助新闻采集更好的运营。二是更加方便用户足不出户管理新闻采集信息。本项目的主要内容可概括如下:

(1)分析当前新闻采集信息管理系统需求和应用。

(2)基于关系型数据库建立共享数据库,方便数据查询、增删改查。

(3)完成整个系统设计。系统管理员可以添加、修改和删除新闻采集信息。

本项目设计的主要意义可概括为以下几点:

(1)确保系统对新闻采集的信息管理准确、快捷。

(2)方便系统管理员管理信息的增删改查。

(3)成本低,易于管理,能满足不同新闻的需求采集。

任何信息只有经过整合和分析才能产生价值。分散的信息只能是新闻,不能体现真正的商业价值。

1.2 开发系统的意义

通常,新闻专业或大型门户网站网站都有自己的新闻频道或专业的编辑人员,这往往需要很高的成本。news采集系统在资源比较匮乏的情况下,通过程序进行远程爬取。自动采集 和资源共享,无需人工干预。一方面可以保证信息更加及时有效,另一方面可以提高工作效率,减轻编辑负担。为企业提供可靠的信息来源,降低可观的成本。我要完成的设计可以通过各种手段采集到每个网站的一些杂乱而庞大的信息,总结分析出很多有用和有价值的信息。

随着计算机技术和网络技术的飞速发展,各大网站纷纷采用信息技术管理新闻采集相关信息。但是我也注意到很多网站没有很好地利用现代信息技术来管理新闻采集等信息,很多新闻采集系统把所有的管理事务都交给了管理。需要管理员手动完成。如果对信息有任何增删改查,都需要管理员来做,非常麻烦。如何开发一个实用的新闻采集系统是设计师的一大难题。

通过对新闻采集系统的深入分析研究,可以从功能模块、数据格式、通用性三个方面对其进行细化,提出新闻采集的理论基础和实现方法。系统设计。设计系统的三层数据主要体现了数据格式的规范,也为通用性的实现提供了保障。最后,在系统开发中,从技术层面实现代码的可重用性和系统的通用性,使系统的设计更加灵活和熟练。总之,逐渐发展起来的信息系统可以让办公管理变得非常灵活。每个角色都有自己的权限,保证了信息的安全性和沟通的简单性。因此,基于MVC的新闻< @采集系统将是未来的趋势。所以我通过开发一个新闻采集 系统来实现更好的连接。

从商业角度来看,新闻采集网站还是很有前景的。动态网络技术的出现彻底改变了传统的互联网模式。它使网站管理员更容易更新其网站的内容信息。同时也让网络的应用更加丰富。使用动态 Web 技术实现的应用程序如雨后春笋般涌现。新闻采集系统现在发展迅速。

1.3 问题描述

本项目的目标是通过news采集系统中的浏览器从客户端访问服务器上系统的应用程序。本系统是现代市场经济条件下新闻采集管理部门对新闻采集信息进行管理和查询的行业化系统。主要实现以下目标:

(1)系统整体结构及运行过程合理流畅,实现人性化设计。

(2)让客户了解新闻采集管理的所有流程和管理理念。上一篇:C#队列调用系统软件设计+文献回顾下一篇:HC显着性检测PIF算法研究+sqlserver校园二手交易盘系统设计ASP.NET+SQLServer网络课程问答系统设计+ER图ASP.NET《Photoshop应用技术》...淮安旅游文化品牌营销策略研究SC胶囊制备与质量检验+文献综述遥感图像融合全色锐化算法研究中学地理生活教学研究胶带剥离机结构设计+CAD图纸+国防PPT 我国引进外商直接投资的问题及对策

资讯内容采集系统(CMS内容管理平台:编辑1小时内可视化快速建专题)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2022-03-03 14:04

cms内容管理平台是具有自主知识产权的管理系统,应用于广电音视频运营。系统采用模块化设计,对广电多屏流媒体播控进行系统、全面的管理。系统以内容管理和用户为主,负责电视节目列表、影视节目、服务器等内容信息的管理。为数据广播业务的市场化运营提供了良好的平台。

cms内容管理平台配备强大的稿件、图片、视频编辑发布功能采集,集内容创作、审阅、发布于一体;支持网站由网站栏目和频道栏目组织,提供会计专题设计、制作和发布功能;提供丰富的栏目管理、模板管理以及站点和页面发布功能;提供全站内容的稿件、图片、视频和评论等精准检索功能;提供全面的用户管理、系统管理和报表统计管理功能。

cms可与VMS视频管理系统、网络流媒体收录系统、在线视频编辑系统、媒体资产管理系统、流媒体播控系统、广告管理发布系统、社区交互论坛系统紧密集成,提供创新的一体化、高效的全媒体技术平台。

产品特点

提供从信息内容采集、组织、发布、传播、交互、数据挖掘到盈利的一体化解决方案,是网络广播电视台网站首选产品cms和媒体。

领先信息发布:支持一键排版、插入投票/延伸阅读、批量上传、自动关键词内链、相关文章、相关视频等功能。

超可视化话题功能:编辑1小时内可视化快速构建话题,无需技术合作,降低人工成本,缩短制作周期。

灵活的页块维护功能; 网站和频道首页的区块维护可视化,支持不定期新闻,自由整理内容。强大的编辑评价功能;按月生成关于编辑提交、访问、评论和评分数量的报告,并导出到 EXCEL。

内置问卷调查功能;支持可视化自定义调查表格,自动生成调查报告,可复合统计,可导出EXCEL。内置强大的图片编辑、视频上传、视频编辑、视频转码等功能。

主要功能

群组管理——群组管理、添加、删除、查询群组管理;

资源库管理——主要负责视频资源的增删改;

板块服务包——将资源库中的资源整合到一个面板中;

媒体资产包管理——管理打包的媒体资产;

产品计费包——主要实现打包产品的计费管理功能;

系统配置-主要负责平台的系统配置;

权限管理——主要负责本平台各模块的权限管理;

模板管理——主要负责与本平台相关的模板管理;

终端管理——主要负责终端类型管理,以及终端管理、用户管理;

CP/SP管理-合作伙伴管理、添加、删除、查询合作伙伴;

应用程序

cms内容管理平台可广泛应用于IPTV建设、网络广播电视台、移动电视台、媒体网站、门户网站、企业集团网站 等系统。还可以为政府、教育等门户网站建设提供强有力的支持网站。 查看全部

资讯内容采集系统(CMS内容管理平台:编辑1小时内可视化快速建专题)

cms内容管理平台是具有自主知识产权的管理系统,应用于广电音视频运营。系统采用模块化设计,对广电多屏流媒体播控进行系统、全面的管理。系统以内容管理和用户为主,负责电视节目列表、影视节目、服务器等内容信息的管理。为数据广播业务的市场化运营提供了良好的平台。

cms内容管理平台配备强大的稿件、图片、视频编辑发布功能采集,集内容创作、审阅、发布于一体;支持网站由网站栏目和频道栏目组织,提供会计专题设计、制作和发布功能;提供丰富的栏目管理、模板管理以及站点和页面发布功能;提供全站内容的稿件、图片、视频和评论等精准检索功能;提供全面的用户管理、系统管理和报表统计管理功能。

cms可与VMS视频管理系统、网络流媒体收录系统、在线视频编辑系统、媒体资产管理系统、流媒体播控系统、广告管理发布系统、社区交互论坛系统紧密集成,提供创新的一体化、高效的全媒体技术平台。

产品特点

提供从信息内容采集、组织、发布、传播、交互、数据挖掘到盈利的一体化解决方案,是网络广播电视台网站首选产品cms和媒体。

领先信息发布:支持一键排版、插入投票/延伸阅读、批量上传、自动关键词内链、相关文章、相关视频等功能。

超可视化话题功能:编辑1小时内可视化快速构建话题,无需技术合作,降低人工成本,缩短制作周期。

灵活的页块维护功能; 网站和频道首页的区块维护可视化,支持不定期新闻,自由整理内容。强大的编辑评价功能;按月生成关于编辑提交、访问、评论和评分数量的报告,并导出到 EXCEL。

内置问卷调查功能;支持可视化自定义调查表格,自动生成调查报告,可复合统计,可导出EXCEL。内置强大的图片编辑、视频上传、视频编辑、视频转码等功能。

主要功能

群组管理——群组管理、添加、删除、查询群组管理;

资源库管理——主要负责视频资源的增删改;

板块服务包——将资源库中的资源整合到一个面板中;

媒体资产包管理——管理打包的媒体资产;

产品计费包——主要实现打包产品的计费管理功能;

系统配置-主要负责平台的系统配置;

权限管理——主要负责本平台各模块的权限管理;

模板管理——主要负责与本平台相关的模板管理;

终端管理——主要负责终端类型管理,以及终端管理、用户管理;

CP/SP管理-合作伙伴管理、添加、删除、查询合作伙伴;

应用程序

cms内容管理平台可广泛应用于IPTV建设、网络广播电视台、移动电视台、媒体网站、门户网站、企业集团网站 等系统。还可以为政府、教育等门户网站建设提供强有力的支持网站。

资讯内容采集系统(【体育资讯】多条采集规则的归属栏目介绍(一) )

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2022-03-02 10:01

)

详细介绍

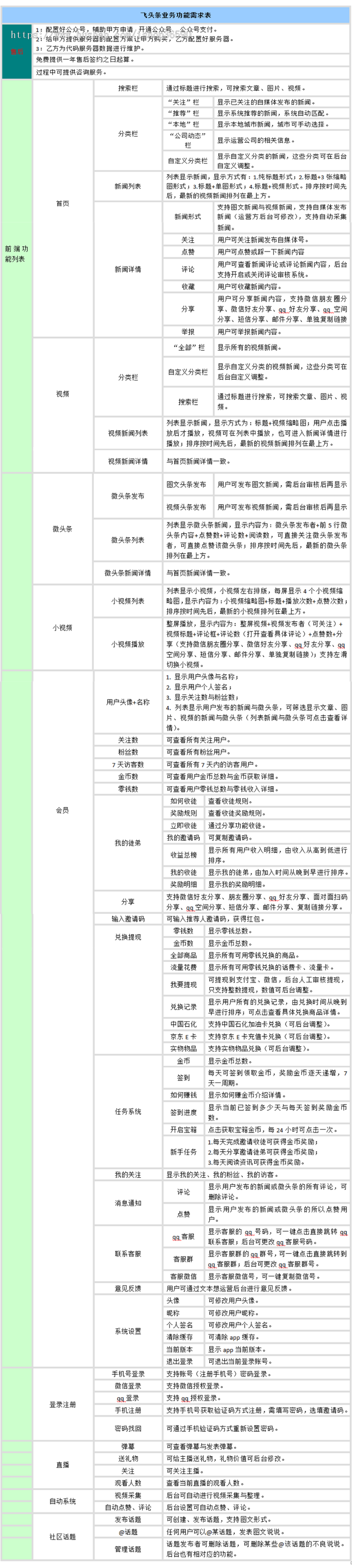

本插件可通过天人官方采集平台转入获取每日更新的文章(旧的文章不是采集)40多个类别的体育资讯,就是说能拿到全网海量实时更新的最新文章。可配合自动采集插件实现自动免维护更新网站功能。

先说:

这样的采集规则插件会消耗大量的服务器资源和成本,所以每年都需要更新插件。授权包2及以上用户,授权内任意域名,安装本插件后可免费使用本插件一年,之后每年半价继续使用本插件。

未购买授权用户或授权级别低于套餐2的用户需按原价单独购买续费。

授权用户只需半价续订最昂贵的采集规则插件之一,所有网站用户均可免费使用所有采集规则插件。比如你每年只需要更新一个99元的采集规则插件,半价49.5元,所有网站都可以继续使用99元及以下免费 采集 规则插件一年。

指示:

安装完成后,在网站后台--采集管理--规则管理中,可以点击规则前面的采集按钮,执行单独的采集,或者你可以选择多个采集。

编辑方法:

安装完成后,在网站后台--采集管理--规则管理,会看到多条采集规则。这些采集规则的归属列默认是你的网站id为1的列,默认设置是把远程图片保存到你的服务器。因此,请根据实际情况将采集规则归属列设置为其他列。方法是:网站后台--采集管理--规则管理--点击一个项目采集规则前面的“编辑”按钮--一个分类--选择你的类别--单击下一步保存当前页面的设置。

如果不想将远程图片保存到服务器采集,方法是:网站后台--采集管理--规则管理--点击前面的一个采集规则“编辑”按钮--新闻设置--保存图片--取消勾选--点击下一步保存当前页面的设置。

设置默认固定作者名,方法:URL后台--采集管理--规则管理--点击采集规则前面的“编辑”按钮--下一步--下一步--作者设置--填写固定字符。

如何将采集 之后的数据发布到网站?方法:网站后台--采集管理--数据存储,可以选择存储全部内容或者勾选部分内容进行存储,也可以删除全部内容或者删除部分勾选内容.

为什么内容提示的采集部分在采集之后重复出现?因为:为了防止重复采集浪费不必要的时间和资源,如果要重新采集已经采集的数据,请到网站后台-- 采集管理--历史记录,可以在这里删除历史记录或者选择性删除“成功记录”、“失败记录”、“无效记录”,在内部页面顶部的标题栏中过滤浏览器。

常见问题:

安装好的采集规则可以修改吗?

答:“目标网页编码”和“远程列表URL”不能修改。其他内容请谨慎修改,否则容易失败采集。

为什么我采集时提示“服务器资源有限,无法直接浏览此文章。请批量安装或升级采集插件采集”?

A:1、“目标网页编码”和“远程列表URL”不能修改。其他内容请谨慎修改,否则容易失败采集。. 2、查看你登录后台的域名是否获取到采集规则插件的注册码。3、请直接进入采集,不要点击测试按钮,测试时会出现这个提示。正常 采集 没问题。4、请使用您安装此插件时使用的域名登录后台采集。

这个插件的优点:

平台每日自动更新采集内容,所有内容自动排版,无需重新编辑。

天仁系列管理系统所有系统均可使用,并自动匹配按键样式。

此插件不是自动采集插件,需要点击按钮触发批处理采集

安装过程

单击上方的立即安装按钮(如下图所示):

等待1分钟后,会出现黑底蓝字的“Loading”页面(如下图)

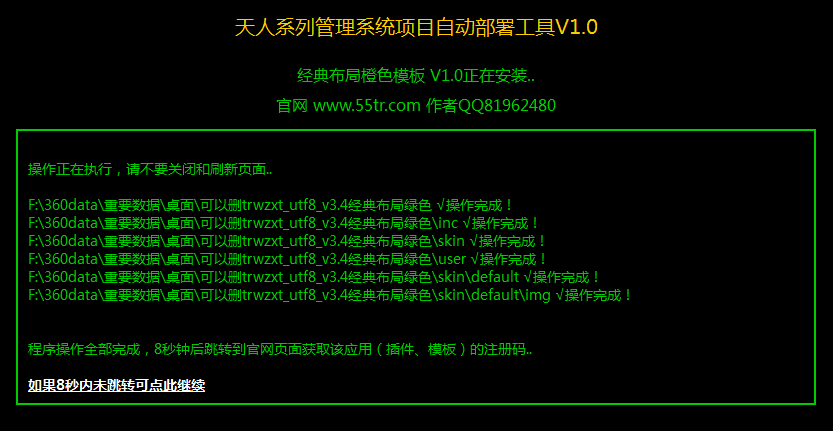

然后稍等片刻,页面会变成黑底绿色字体的“天人系列管理系统项目自动部署工具”(如下图)

如果页面上的所有权限检查通过,并且没有出现红色字体的“不可读”、“无法写入”和“无法删除”字样,则会自动安装。几分钟后会提示安装完成,不要关闭页面,8秒后会跳转到官网获取注册码,然后就可以使用这个应用了。

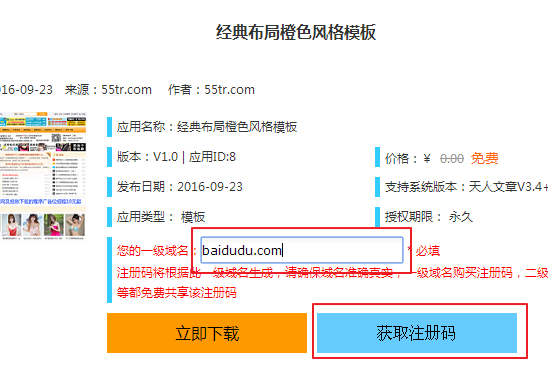

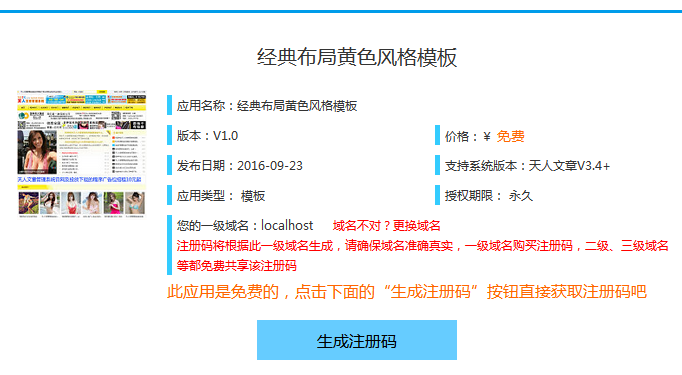

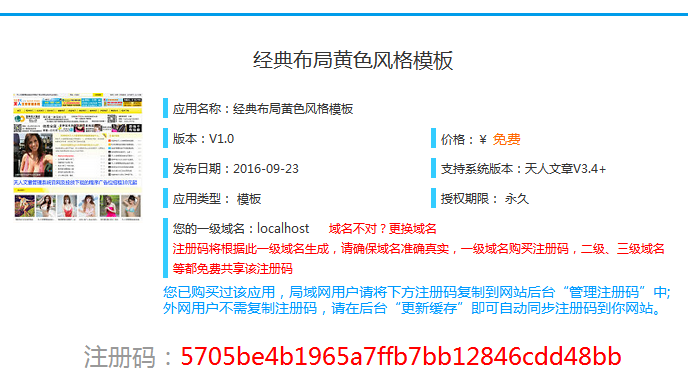

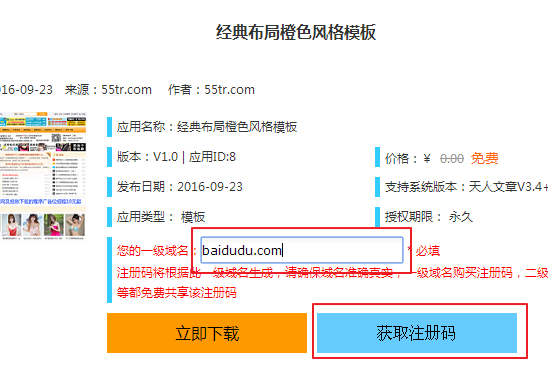

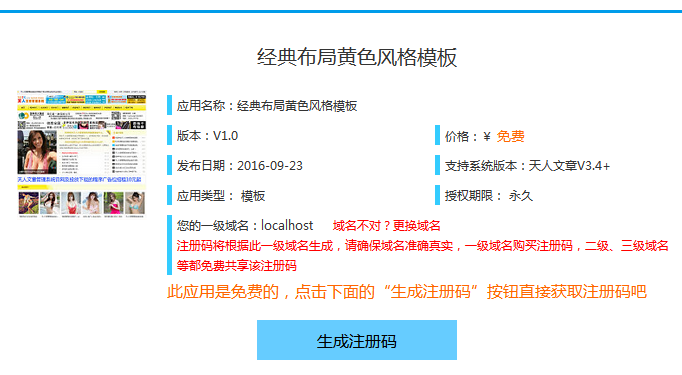

获取注册码页面,点击“生成注册码”按钮(如下图)

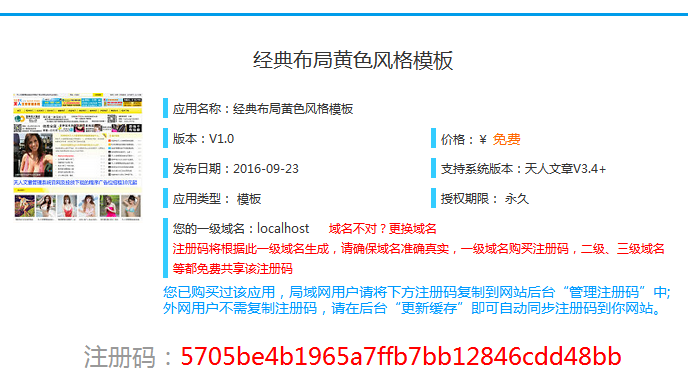

这时候系统会根据你的域名自动生成一个注册码(如下图)