自动采集网站内容

自动采集网站内容(#全网网址采集器全网可用在哪里运行本采集器可用运行 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-09-03 23:04

)

整个网站采集器(cobweb)

这是一个golang写的网站采集器,可以自动抓取所有可以到达的网站信息。 URL采集器会自动采集并分析网站的标题、站点描述、微信、QQ、联系方式、网站使用的运行环境、ip信息等,甚至分析使用的框架网站。

全新升级,使用sqlite作为数据库,不再需要安装mysql,直接运行可执行文件即可抓取内容。

为什么全网URL采集器全网URL采集器能采集什么内容

这个采集器can采集的内容是:文章title、文章关键词、文章description、文章detailed content、文章author、文章release time、 文章views。

##全网网站采集器可以运行的地方采集器可以运行在Windows系统、Mac系统、Linux系统(Centos、Ubuntu等),可以下载编译好的程序直接执行,或者你可以下载源代码自己编译。

如何安装和使用

go env -w GOPROXY=https://goproxy.cn,direct

最后执行如下命令

go mod tidy

go mod vendor

go build app/main.go

## 跨平台编译Windows版本

CGO_ENABLED=1 CC=x86_64-w64-mingw32-gcc CXX=x86_64-w64-mingw32-g++ GOOS=windows GOARCH=amd64 go build -x -v -ldflags "-s -w" -o cobweb.exe ./app/main.go 查看全部

自动采集网站内容(#全网网址采集器全网可用在哪里运行本采集器可用运行

)

整个网站采集器(cobweb)

这是一个golang写的网站采集器,可以自动抓取所有可以到达的网站信息。 URL采集器会自动采集并分析网站的标题、站点描述、微信、QQ、联系方式、网站使用的运行环境、ip信息等,甚至分析使用的框架网站。

全新升级,使用sqlite作为数据库,不再需要安装mysql,直接运行可执行文件即可抓取内容。

为什么全网URL采集器全网URL采集器能采集什么内容

这个采集器can采集的内容是:文章title、文章关键词、文章description、文章detailed content、文章author、文章release time、 文章views。

##全网网站采集器可以运行的地方采集器可以运行在Windows系统、Mac系统、Linux系统(Centos、Ubuntu等),可以下载编译好的程序直接执行,或者你可以下载源代码自己编译。

如何安装和使用

go env -w GOPROXY=https://goproxy.cn,direct

最后执行如下命令

go mod tidy

go mod vendor

go build app/main.go

## 跨平台编译Windows版本

CGO_ENABLED=1 CC=x86_64-w64-mingw32-gcc CXX=x86_64-w64-mingw32-g++ GOOS=windows GOARCH=amd64 go build -x -v -ldflags "-s -w" -o cobweb.exe ./app/main.go

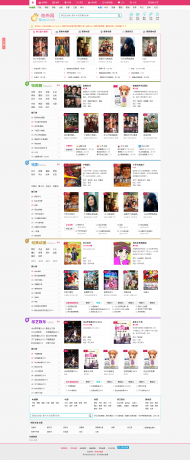

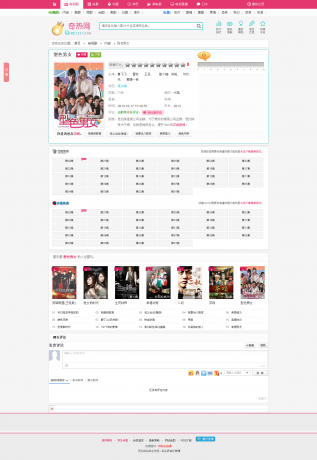

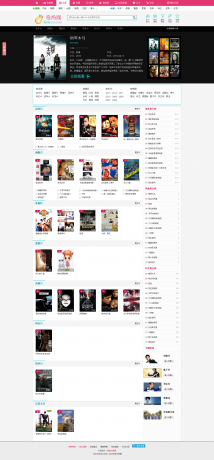

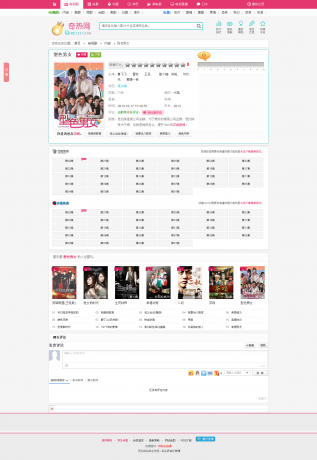

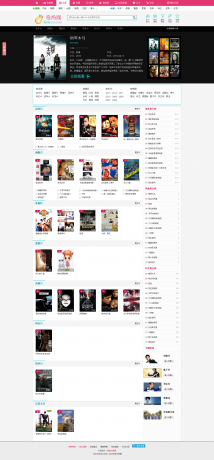

自动采集网站内容(马克斯4.0内核的2013最新奇热电影网源码,极具商业价值源码)

采集交流 • 优采云 发表了文章 • 0 个评论 • 188 次浏览 • 2021-09-03 22:24

Max4.0内核2013最新奇热电影网全站源码,一组极具商业价值的源码,网上随处可见小贩。这里发布的奇瑞影业全站源码完全可用且完整,全站生成静态页面

背景路径您的网址/管理员

管理账号和密码分别是admin

源码架构:ASP+ACCESS(mssql)(源码附详细安装说明)

源码说明:新增功能全自动采集+无人值守,加入迅雷下载电影,mp3 mp4,3万余条原创资料,主栏目,影视剧,电影动漫,综艺,微电影,留言看板、电影排行、口水、电视直播,页面可以显示asp+acc或者选择mssql。全站可以选择动态、伪静态、全静态的群站主,有福了!

特殊功能:

1、简洁却不大气的界面让用户流连忘返。

2、新颖的历史浏览记录,在不影响界面美观的同时,也增加了用户的停留时间。

3、电影电视剧独有的幻灯片完全自动调用,免去手动更新幻灯片的麻烦。

4、支持迅雷下载,在线观看和离线下载都正确。

5、调整栏目页面,以字母形式显示,更类似于Qi Hot。

6、一键采集,每天更新内容方便搜索引擎抓取。

7、触发自动采集,只要有流量,就可以实现采集自动更新。

8、逆序添加播放列表,让最新一集不会沉底!

9、首页增加公告提醒。直接后台管理更方便。

10、新增口水排行榜,将评论替换为大纲,防止垃圾评论过多影响网站的专业性。

11、 简洁专题名人专页,想看哪部名人电影,想看就点多看。

下载链接:

下载地址 查看全部

自动采集网站内容(马克斯4.0内核的2013最新奇热电影网源码,极具商业价值源码)

Max4.0内核2013最新奇热电影网全站源码,一组极具商业价值的源码,网上随处可见小贩。这里发布的奇瑞影业全站源码完全可用且完整,全站生成静态页面

背景路径您的网址/管理员

管理账号和密码分别是admin

源码架构:ASP+ACCESS(mssql)(源码附详细安装说明)

源码说明:新增功能全自动采集+无人值守,加入迅雷下载电影,mp3 mp4,3万余条原创资料,主栏目,影视剧,电影动漫,综艺,微电影,留言看板、电影排行、口水、电视直播,页面可以显示asp+acc或者选择mssql。全站可以选择动态、伪静态、全静态的群站主,有福了!

特殊功能:

1、简洁却不大气的界面让用户流连忘返。

2、新颖的历史浏览记录,在不影响界面美观的同时,也增加了用户的停留时间。

3、电影电视剧独有的幻灯片完全自动调用,免去手动更新幻灯片的麻烦。

4、支持迅雷下载,在线观看和离线下载都正确。

5、调整栏目页面,以字母形式显示,更类似于Qi Hot。

6、一键采集,每天更新内容方便搜索引擎抓取。

7、触发自动采集,只要有流量,就可以实现采集自动更新。

8、逆序添加播放列表,让最新一集不会沉底!

9、首页增加公告提醒。直接后台管理更方便。

10、新增口水排行榜,将评论替换为大纲,防止垃圾评论过多影响网站的专业性。

11、 简洁专题名人专页,想看哪部名人电影,想看就点多看。

下载链接:

下载地址

自动采集网站内容(自动采集网站内容是大部分站长进行优化时最常用的方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2021-09-02 02:05

自动采集网站内容是大部分站长进行优化时最常用的方法,

1、博客发布

2、论坛发布

3、中文网站发布内容

4、谷歌发布

5、b2b发布/b2b/

6、百度知道

7、问答网站

8、百度百科

9、龙空1

0、58发布1

1、百度百科1

2、百度知道1

3、百度贴吧1

4、谷歌快照-最大全球站长社区

1、全站高清的图片加快了网站页面的打开速度,

2、对网站页面按照类型进行分类,让搜索引擎能够根据不同的内容进行不同的分类,

3、对站内标题栏和对应的网页锚文本进行字体颜色的改变,提高网站在百度中的抓取效果,改变搜索引擎对网站页面的排序,

4、添加关键词导航、一级页面、二级页面等高质量的网页内容,

5、增加html文本内容,让用户轻松输入引起,进行内容的搜索。

6、不要只做网站的主页,可以同时做几个页面,这样可以让搜索引擎对网站页面做到更深层次的检索,

7、对于那些短小精悍的页面,可以添加图片,增加页面的丰富度。

8、同类型的网站页面一般都会通过同样的方式进行网站页面的搜索,让搜索引擎对该站有一个良好的体验,形成一个良性循环。不过还是有很多站长对此没有采取。另外还有一个隐藏技能:8.2浏览器内核。高速ms内核显示9.3杀毒软件或防火墙可能是网站被搜索引擎判断为竞争对手的关键。它们对网站内部的内容进行对比然后进行行为的惩罚甚至降权。

因此搜索引擎可能会在你浏览其他网站或搜索引擎链接时给你带来不良反应。因此,防止这些危险因素发生你的网站就变得尤为重要。 查看全部

自动采集网站内容(自动采集网站内容是大部分站长进行优化时最常用的方法)

自动采集网站内容是大部分站长进行优化时最常用的方法,

1、博客发布

2、论坛发布

3、中文网站发布内容

4、谷歌发布

5、b2b发布/b2b/

6、百度知道

7、问答网站

8、百度百科

9、龙空1

0、58发布1

1、百度百科1

2、百度知道1

3、百度贴吧1

4、谷歌快照-最大全球站长社区

1、全站高清的图片加快了网站页面的打开速度,

2、对网站页面按照类型进行分类,让搜索引擎能够根据不同的内容进行不同的分类,

3、对站内标题栏和对应的网页锚文本进行字体颜色的改变,提高网站在百度中的抓取效果,改变搜索引擎对网站页面的排序,

4、添加关键词导航、一级页面、二级页面等高质量的网页内容,

5、增加html文本内容,让用户轻松输入引起,进行内容的搜索。

6、不要只做网站的主页,可以同时做几个页面,这样可以让搜索引擎对网站页面做到更深层次的检索,

7、对于那些短小精悍的页面,可以添加图片,增加页面的丰富度。

8、同类型的网站页面一般都会通过同样的方式进行网站页面的搜索,让搜索引擎对该站有一个良好的体验,形成一个良性循环。不过还是有很多站长对此没有采取。另外还有一个隐藏技能:8.2浏览器内核。高速ms内核显示9.3杀毒软件或防火墙可能是网站被搜索引擎判断为竞争对手的关键。它们对网站内部的内容进行对比然后进行行为的惩罚甚至降权。

因此搜索引擎可能会在你浏览其他网站或搜索引擎链接时给你带来不良反应。因此,防止这些危险因素发生你的网站就变得尤为重要。

自动采集网站内容(海洋cms怎么设置宝塔自动采集:获取脚本代码。)

采集交流 • 优采云 发表了文章 • 0 个评论 • 216 次浏览 • 2021-09-01 07:23

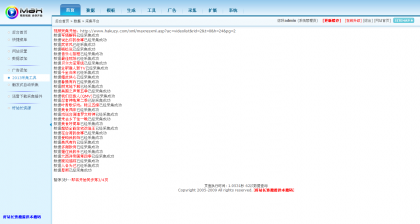

Oceancms如何设置宝塔自动采集,因为很多人都在问这个问题,所以有这个教程。虽然oceancms给出了脚本代码,但是对于刚接触oceancms的用户来说,理解并不是那么容易。今天就详细介绍一下使用海洋cms自动采集的具体步骤。

Oceancms如何设置宝塔自动采集第一步:获取脚本代码。

[1] 以下是Oceancms官网提供的自动采集脚本代码。我们需要修改代码中的3项才可以使用。

#!/bin/bash

########################################################

# 程序名称: 海洋CMS自动采集脚本

# 版本信息:seacmsbot/ v2.0

# 发布链接: https://www.seacms.net/post-update-92579.htm

# 使用方法:直接复制代码到宝塔计划任务shell脚本内容里添加每小时任务使用

# 更新时间:2019.9.26

##########################################################

# ①请修改下面的网站域名及管理目录

web_site = "http://网站域名/管理目录/admin_reslib2.php"

# ②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd = "8888e82e85bd4540f0defa3fb7a8e888"

# ③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

# 每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api = (

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

# 模拟用户浏览器ua,请勿随意修改,以免被目标防火墙拦截!

web_ua = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko)

Chrome / 76.0

.3809

.100

Safari / 537.36

seacmsbot / 1.2;

"

# 采集单页

function

get_content()

{

echo

"正在采集第$page页..."

# echo " get_content: --->url:--->$1"

cResult =$(curl - -connect - timeout 10 -m 20 -k -s -L -A "$web_ua" "$1")

echo $cResult | grep - q

"采集"

# echo -e "$1\n$cResult"

if ["$?" = "0"]; then

next_content

"$cResult"

else

echo - e

"采集失败,请检查设置!\n失败链接-->$1\n返回信息-->$cResult\n采集结束,共0页"

fi

}

# 采集下页

function

next_content()

{

# 统计数据

Result =$(echo "$1" | tr "

" "\n")

a =$(echo "$Result" | grep -c "采集成功")

b =$(echo "$Result" | grep -c "更新数据")

c =$(echo "$Result" | grep -c "无需更新")

d =$(echo "$Result" | grep -c "跳过")

echo

"采集成功-->已更$c部,新增$a部,更新$b部,跳过$d部"

let

add +=$a

let

update +=$b

let

none +=$c

let

jmp +=$d

# 检测并采集下页

next_url =${1 ##*location.href=\'}

next_url =${next_url % %\'*}

# echo $next_url

if ["${next_url:0:1}" = "?"]

then

let

page + +

get_content

"$web_site$next_url"

else

echo

"采集结束,共$page页"

fi

}

# 脚本入口

echo

"海洋CMS自动采集脚本开始执行 版本:v1.2"

starttime =$(date +% s)

update = 0 # 更新

add = 0 # 新增

none = 0 # 无变化

jmp = 0 # 跳过

for url in ${web_api[@]};

do

if[[! -z $url]]

then

web_param="$web_site$url&password=$web_pwd"

page=1

echo "开始采集:$url"

get_content $web_param

fi

done

endtime=$(date + % s)

echo "============================"

echo "入库-->$add部"

echo "更新-->$update部"

echo "跳过-->$jmp部(未绑定分类或链接错误)"

echo "今日-->$[none+add+update]部"

echo "============================"

echo "全部采集结束,耗时$[endtime - starttime]秒"

Oceancms如何设置宝塔自动采集 第二步:修改脚本

[2] 脚本中的哪3项需要特别修改?让我为你一一讲述。 (根据上面提供的代码内容,复制到记事本或者其他html编辑器进行相应修改)

#①请修改下面的网站域名及管理目录

web_site="http://网站域名/管理目录/admin_reslib2.php"

这里要修改为你的“网站域名”和“seacmsbackground 管理目录”。每个人都可以理解域名。后端管理目录需要新手多说几句。首先,您必须能够登录到您的后端以了解您的后端目录。比如:如果我的后台登录地址是,那么这里的文章就是后台管理目录,拿到管理目录的时候直接填写代码即可。

#②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd="8888e82e85bd4540f0defa3fb7a8e888"

#③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

#每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api=(

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

这是代码中需要修改的最后一项。里面是代码中默认提供的两个采集链接地址。我们需要获取我们的采集 链接地址并将其添加到其中。关于获取链接地址的详细信息,请参见下面的屏幕截图。步操作。如果你还没有添加或者不知道如何添加采集,可以参考帮助文档-oceancms如何添加资源库采集interface

选择“后台-采集-资源库列表”,复制资源站右侧“采集今日”、“采集今日”、“采集全”的链接地址根据您的选择,并删除 ?之前的内容。 (当天或本周将鼠标移至采集,鼠标右击复制链接即可获得采集链接)

例如,这里是:

1

:///inc/ldg_seackm3u8s.php

第 2 步:删除“?”之前的内容复制上一步,结果如下:

2

?ac=day&rid=1&url=

这样就得到了最终的采集 URL

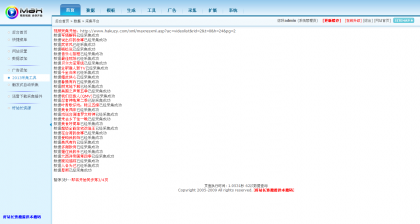

Oceancms如何设置宝塔自动采集 第三步:设置宝塔定时任务。

【3】直接将代码复制到宝塔计划任务的shell脚本中,并在内容中添加小时任务。具体步骤如下截图。步骤⑤是将我们修改后的脚本复制粘贴到脚本内容框中。

4] 总结

一般来说,在脚本中修改几个需要修改的项目后,将修改后的脚本复制到宝塔的定时任务设置中。安排采集task 就足够了。不要选择错误的任务类型。如果您对本教程不了解或有任何疑问,可以加入社区进行讨论和查询。 查看全部

自动采集网站内容(海洋cms怎么设置宝塔自动采集:获取脚本代码。)

Oceancms如何设置宝塔自动采集,因为很多人都在问这个问题,所以有这个教程。虽然oceancms给出了脚本代码,但是对于刚接触oceancms的用户来说,理解并不是那么容易。今天就详细介绍一下使用海洋cms自动采集的具体步骤。

Oceancms如何设置宝塔自动采集第一步:获取脚本代码。

[1] 以下是Oceancms官网提供的自动采集脚本代码。我们需要修改代码中的3项才可以使用。

#!/bin/bash

########################################################

# 程序名称: 海洋CMS自动采集脚本

# 版本信息:seacmsbot/ v2.0

# 发布链接: https://www.seacms.net/post-update-92579.htm

# 使用方法:直接复制代码到宝塔计划任务shell脚本内容里添加每小时任务使用

# 更新时间:2019.9.26

##########################################################

# ①请修改下面的网站域名及管理目录

web_site = "http://网站域名/管理目录/admin_reslib2.php"

# ②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd = "8888e82e85bd4540f0defa3fb7a8e888"

# ③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

# 每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api = (

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

# 模拟用户浏览器ua,请勿随意修改,以免被目标防火墙拦截!

web_ua = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko)

Chrome / 76.0

.3809

.100

Safari / 537.36

seacmsbot / 1.2;

"

# 采集单页

function

get_content()

{

echo

"正在采集第$page页..."

# echo " get_content: --->url:--->$1"

cResult =$(curl - -connect - timeout 10 -m 20 -k -s -L -A "$web_ua" "$1")

echo $cResult | grep - q

"采集"

# echo -e "$1\n$cResult"

if ["$?" = "0"]; then

next_content

"$cResult"

else

echo - e

"采集失败,请检查设置!\n失败链接-->$1\n返回信息-->$cResult\n采集结束,共0页"

fi

}

# 采集下页

function

next_content()

{

# 统计数据

Result =$(echo "$1" | tr "

" "\n")

a =$(echo "$Result" | grep -c "采集成功")

b =$(echo "$Result" | grep -c "更新数据")

c =$(echo "$Result" | grep -c "无需更新")

d =$(echo "$Result" | grep -c "跳过")

echo

"采集成功-->已更$c部,新增$a部,更新$b部,跳过$d部"

let

add +=$a

let

update +=$b

let

none +=$c

let

jmp +=$d

# 检测并采集下页

next_url =${1 ##*location.href=\'}

next_url =${next_url % %\'*}

# echo $next_url

if ["${next_url:0:1}" = "?"]

then

let

page + +

get_content

"$web_site$next_url"

else

echo

"采集结束,共$page页"

fi

}

# 脚本入口

echo

"海洋CMS自动采集脚本开始执行 版本:v1.2"

starttime =$(date +% s)

update = 0 # 更新

add = 0 # 新增

none = 0 # 无变化

jmp = 0 # 跳过

for url in ${web_api[@]};

do

if[[! -z $url]]

then

web_param="$web_site$url&password=$web_pwd"

page=1

echo "开始采集:$url"

get_content $web_param

fi

done

endtime=$(date + % s)

echo "============================"

echo "入库-->$add部"

echo "更新-->$update部"

echo "跳过-->$jmp部(未绑定分类或链接错误)"

echo "今日-->$[none+add+update]部"

echo "============================"

echo "全部采集结束,耗时$[endtime - starttime]秒"

Oceancms如何设置宝塔自动采集 第二步:修改脚本

[2] 脚本中的哪3项需要特别修改?让我为你一一讲述。 (根据上面提供的代码内容,复制到记事本或者其他html编辑器进行相应修改)

#①请修改下面的网站域名及管理目录

web_site="http://网站域名/管理目录/admin_reslib2.php"

这里要修改为你的“网站域名”和“seacmsbackground 管理目录”。每个人都可以理解域名。后端管理目录需要新手多说几句。首先,您必须能够登录到您的后端以了解您的后端目录。比如:如果我的后台登录地址是,那么这里的文章就是后台管理目录,拿到管理目录的时候直接填写代码即可。

#②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd="8888e82e85bd4540f0defa3fb7a8e888"

#③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

#每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api=(

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

这是代码中需要修改的最后一项。里面是代码中默认提供的两个采集链接地址。我们需要获取我们的采集 链接地址并将其添加到其中。关于获取链接地址的详细信息,请参见下面的屏幕截图。步操作。如果你还没有添加或者不知道如何添加采集,可以参考帮助文档-oceancms如何添加资源库采集interface

选择“后台-采集-资源库列表”,复制资源站右侧“采集今日”、“采集今日”、“采集全”的链接地址根据您的选择,并删除 ?之前的内容。 (当天或本周将鼠标移至采集,鼠标右击复制链接即可获得采集链接)

例如,这里是:

1

:///inc/ldg_seackm3u8s.php

第 2 步:删除“?”之前的内容复制上一步,结果如下:

2

?ac=day&rid=1&url=

这样就得到了最终的采集 URL

Oceancms如何设置宝塔自动采集 第三步:设置宝塔定时任务。

【3】直接将代码复制到宝塔计划任务的shell脚本中,并在内容中添加小时任务。具体步骤如下截图。步骤⑤是将我们修改后的脚本复制粘贴到脚本内容框中。

4] 总结

一般来说,在脚本中修改几个需要修改的项目后,将修改后的脚本复制到宝塔的定时任务设置中。安排采集task 就足够了。不要选择错误的任务类型。如果您对本教程不了解或有任何疑问,可以加入社区进行讨论和查询。

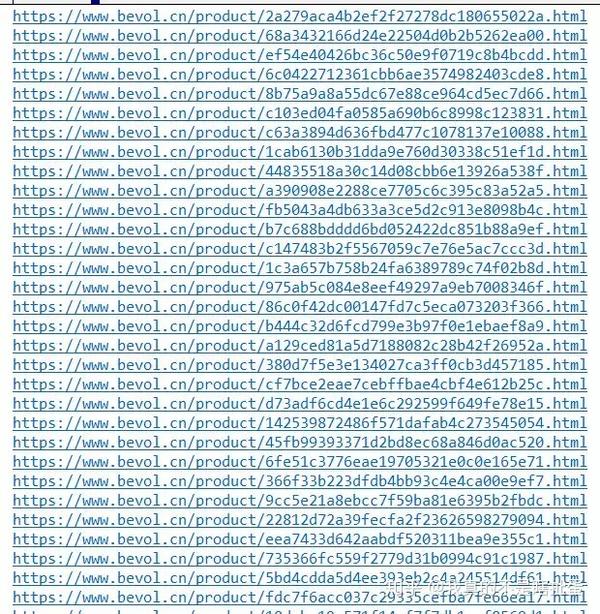

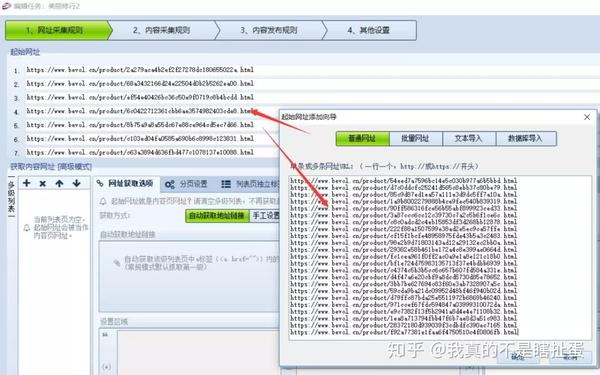

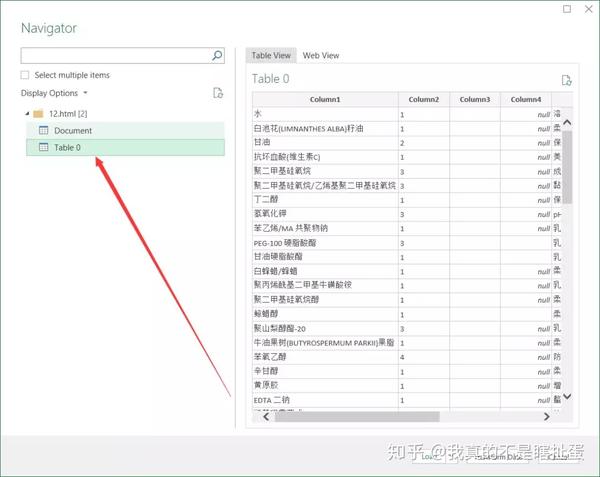

自动采集网站内容(网页中的表格数据指什么样子?如何做到批量采集100页或1000页)

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-09-01 07:17

这种需求似乎很少有人需要,但我认为总会有你需要的那一天。

网页中的表格数据是什么意思?

比如这个我今天要举的例子:

这个产品成分表只是一个数据表。

我们一般使用优采云采集器hard 采集等数据,保持原有结构。

还有优采云采集器,可以智能识别表格数据和采集,但是很多网站无法识别。在上面的示例中我无法识别这一点,因此无法识别采集。 .

但其实excel中有一个功能,就是采集网页中的表格,但是缺点是每次只能采集一页。如何批量处理采集100页或1000页数据?不能一个一个手动做吗?

试了试,最后还是用了excel的采集表格功能,不过我先采集把这100或1000页的内容,组成一个页面,可以被excel NS识别。

步骤如下:

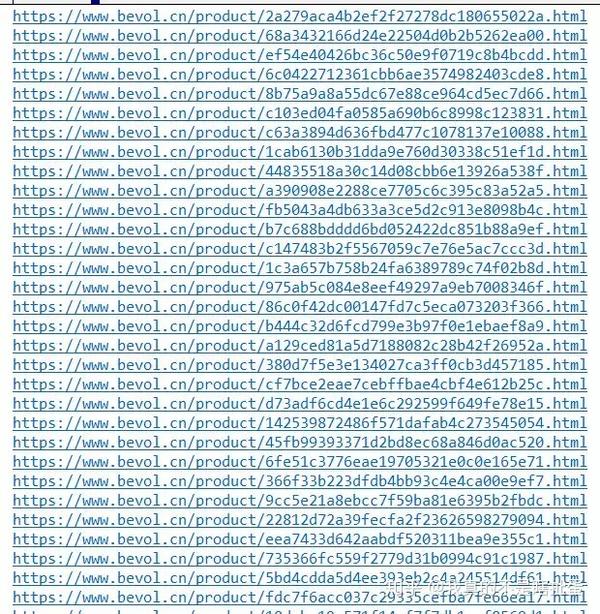

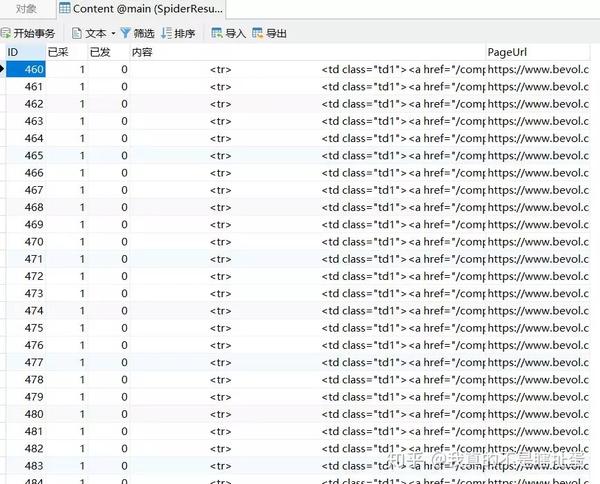

1:优采云采集器采集必填页面

比如我先采集到这些页面的网址。

2、然后整理出来导入优采云采集器

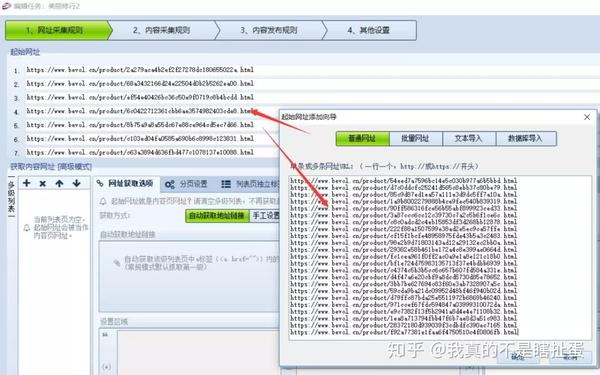

这里注意,应该作为一级页面使用,否则会自动采集下级页面,优采云采集器老版本没有这个问题。

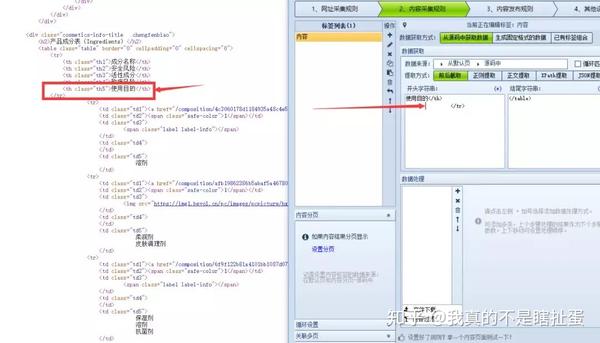

3、然后使用表格的部分html代码

这里是最简单的前后截取方式,采集获取内容,测试一下

获得这样的内容正是我们所需要的。

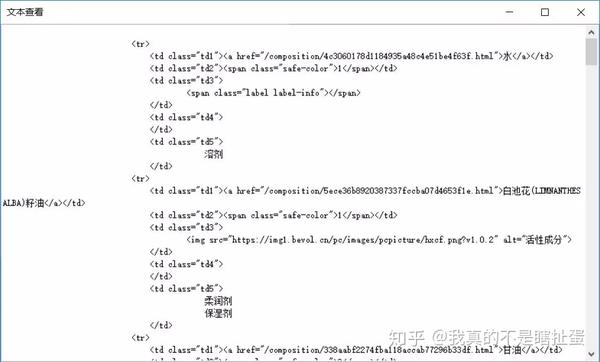

4、batch采集

然后保存任务,批处理采集就可以了。

5、采集complete

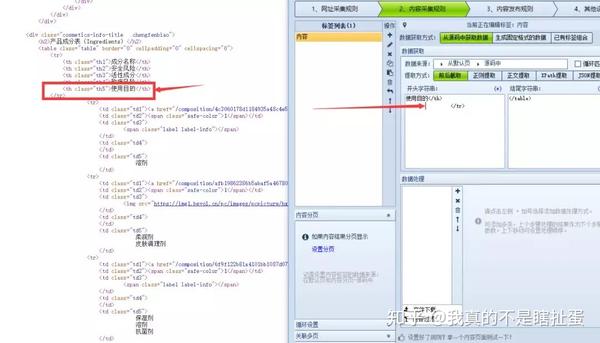

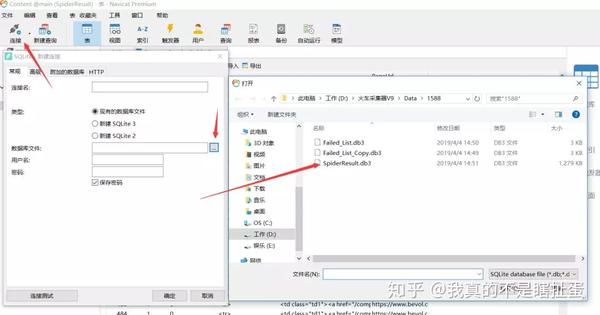

新版优采云采集器默认本地保存为sqlite数据库。没有旧版本的access数据库,所以在office里用access打开是不行的,但是可以用Navicat导入。

链接sqlite,然后选择我们采集到达的db3文件,打开确认。

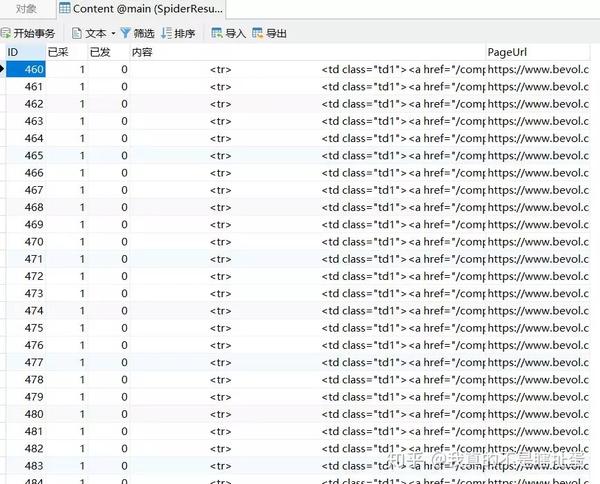

获取以下数据。

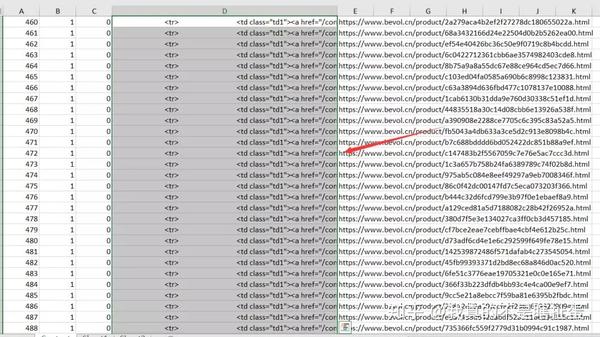

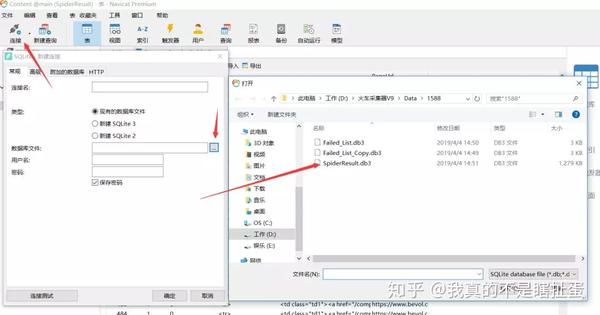

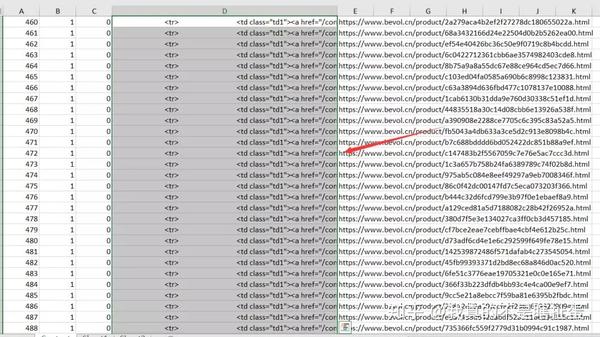

6、Merge 采集来的数据

如果你不知道怎么把数据和数据库合并,也很简单,直接导出excel。

你会在excel中合并吗?即使没有,也只需选择要复制的列。

那我们贴出来看看吧。

获取一个这样的内容。

以 html 文件的形式直接保存到桌面。

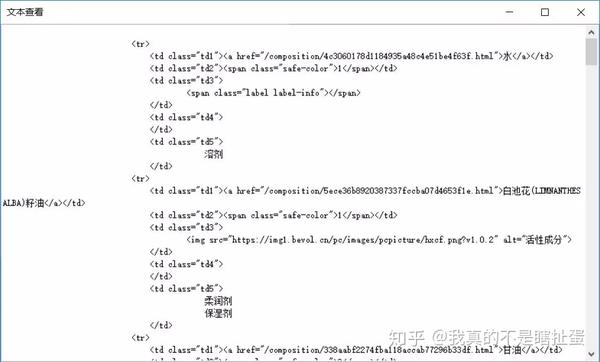

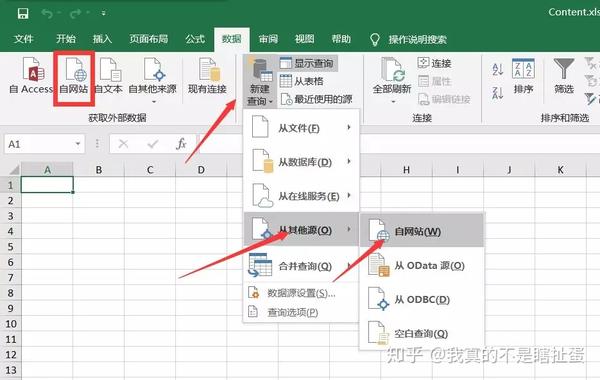

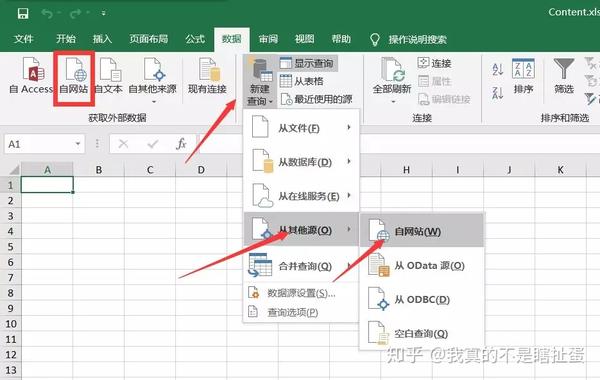

7、excel 被识别为表格数据

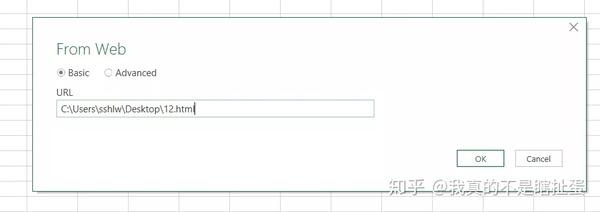

我们选择excel中的数据-new query-since网站(我的excel版本用的是按钮不好用的红框)

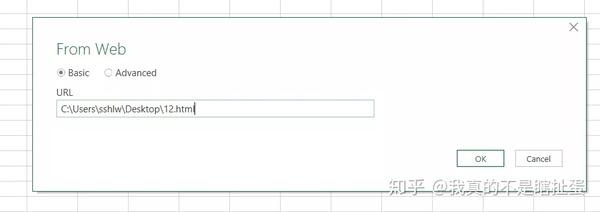

然后填写刚才的html文件的本地地址并确认

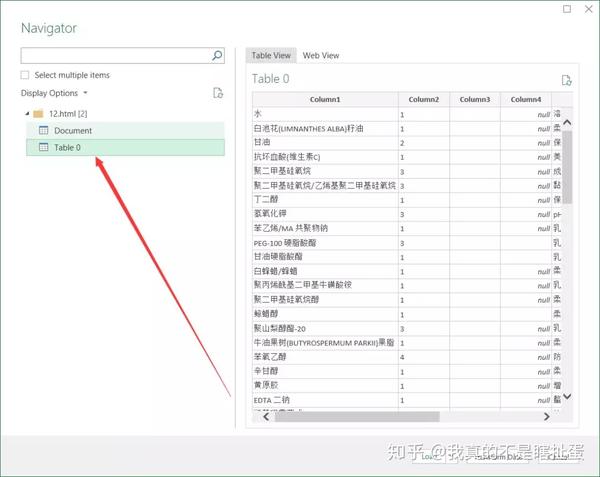

Excel 会识别多种样式的数据,只需选择您想要的一种即可。

8、最终效果

我们得到的最终效果图就是这样的,因为我只有采集有72页,得到了1600行数据。

到这里,你就完成了。 查看全部

自动采集网站内容(网页中的表格数据指什么样子?如何做到批量采集100页或1000页)

这种需求似乎很少有人需要,但我认为总会有你需要的那一天。

网页中的表格数据是什么意思?

比如这个我今天要举的例子:

这个产品成分表只是一个数据表。

我们一般使用优采云采集器hard 采集等数据,保持原有结构。

还有优采云采集器,可以智能识别表格数据和采集,但是很多网站无法识别。在上面的示例中我无法识别这一点,因此无法识别采集。 .

但其实excel中有一个功能,就是采集网页中的表格,但是缺点是每次只能采集一页。如何批量处理采集100页或1000页数据?不能一个一个手动做吗?

试了试,最后还是用了excel的采集表格功能,不过我先采集把这100或1000页的内容,组成一个页面,可以被excel NS识别。

步骤如下:

1:优采云采集器采集必填页面

比如我先采集到这些页面的网址。

2、然后整理出来导入优采云采集器

这里注意,应该作为一级页面使用,否则会自动采集下级页面,优采云采集器老版本没有这个问题。

3、然后使用表格的部分html代码

这里是最简单的前后截取方式,采集获取内容,测试一下

获得这样的内容正是我们所需要的。

4、batch采集

然后保存任务,批处理采集就可以了。

5、采集complete

新版优采云采集器默认本地保存为sqlite数据库。没有旧版本的access数据库,所以在office里用access打开是不行的,但是可以用Navicat导入。

链接sqlite,然后选择我们采集到达的db3文件,打开确认。

获取以下数据。

6、Merge 采集来的数据

如果你不知道怎么把数据和数据库合并,也很简单,直接导出excel。

你会在excel中合并吗?即使没有,也只需选择要复制的列。

那我们贴出来看看吧。

获取一个这样的内容。

以 html 文件的形式直接保存到桌面。

7、excel 被识别为表格数据

我们选择excel中的数据-new query-since网站(我的excel版本用的是按钮不好用的红框)

然后填写刚才的html文件的本地地址并确认

Excel 会识别多种样式的数据,只需选择您想要的一种即可。

8、最终效果

我们得到的最终效果图就是这样的,因为我只有采集有72页,得到了1600行数据。

到这里,你就完成了。

自动采集网站内容(自动采集网站内容一般用zxing,可以直接生成pdf文件阅读)

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-08-30 13:00

自动采集网站内容一般用zxing,语法应该是f2f2f2f2这样的,然后正则表达式用xpath,

用gephi,利用gephi可以很方便做出自己想要的网站内容分析图表。

如果想要数据通过网页传输,网站也要可以浏览的话,

快速采集各大门户网站内容,推荐photopaste。采集完成后可以直接生成pdf文件阅读,

pageminer

其实我们就用pageminer。可以把其中的页面网站采集下来。可以拖拽采集,也可以gif动图采集。采集完直接保存在csv里,但没有合理的分组,查找页面间的关系,整理起来特别困难。

采集各大网站内容,推荐pageminer,采集完成后可以直接生成pdf文件阅读,功能很强大,配合spring,可以快速收集大数据量。

常用的两个是extractor和workmap

如果是采集国内网站,pageminer很不错。如果是国外网站,推荐nemesis和pagelight,可以采集下载,但是不会在浏览器上显示。

pagemate,不需要编程,可以采集网页中的内容,

zxing+gephi

可以自己搭建一个采集网站源代码的工具。

快速采集网站内容,强烈推荐zxing!可以提取网站的内容, 查看全部

自动采集网站内容(自动采集网站内容一般用zxing,可以直接生成pdf文件阅读)

自动采集网站内容一般用zxing,语法应该是f2f2f2f2这样的,然后正则表达式用xpath,

用gephi,利用gephi可以很方便做出自己想要的网站内容分析图表。

如果想要数据通过网页传输,网站也要可以浏览的话,

快速采集各大门户网站内容,推荐photopaste。采集完成后可以直接生成pdf文件阅读,

pageminer

其实我们就用pageminer。可以把其中的页面网站采集下来。可以拖拽采集,也可以gif动图采集。采集完直接保存在csv里,但没有合理的分组,查找页面间的关系,整理起来特别困难。

采集各大网站内容,推荐pageminer,采集完成后可以直接生成pdf文件阅读,功能很强大,配合spring,可以快速收集大数据量。

常用的两个是extractor和workmap

如果是采集国内网站,pageminer很不错。如果是国外网站,推荐nemesis和pagelight,可以采集下载,但是不会在浏览器上显示。

pagemate,不需要编程,可以采集网页中的内容,

zxing+gephi

可以自己搭建一个采集网站源代码的工具。

快速采集网站内容,强烈推荐zxing!可以提取网站的内容,

自动采集网站内容(本篇文章我教大家如何获取Cookies登录状态是通过Cookies判定的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-08-29 18:03

在这篇文章中文章我教你如何采集需要登录网站并自动下载其资源。

获取 Cookie

登录状态由Cookies决定,所以先登录目标网站,按F12打开开发者工具,将Cookies复制到剪贴板如下图。

然后在QQWorld采集器的采集品中新建一个,将复制的Cookies代码粘贴到Cookies输入框中:

设置采集rule 常规设置

设置采集 列表链接、文章 标题和文章 内容选择器。这些都比较简单,这里不再赘述。不明白的请参考QQWorld采集器旗舰采集教程。

采集download 资源

因为填充了cookies,所以在爬取的网页内容中可以看到下载地址的代码,如图:

因为onclick属性中有多余的代码,只用引号括起来的内容就够了,所以要使用正则表达式采集,新建一个自定义列采集,设置方法如图图:

这里设置下载地址保存在win-down自定义列中,由于采集到达的地址是相对地址,需要根据完整地址加前缀。然后检查下载到本地目录。也可以勾选下载到媒体库,但首先要确保Wordpress媒体库允许上传这种格式。

格式文章content

大部分用户不会修改模板,所以不知道如何输出这个下载地址。 QQWorld 采集器提供文章content 格式化工具。在采集项的自动采集设置中,如下图设置:

可以使用四个短代码,分别代表文章content、文章title、文章custom 列和超链接。在自定义列简码的key属性中填写win-down输出下载地址。

结论

遗憾的是,需要付费的内容不能是采集。没有办法做到这一点。

教程到此结束。此功能应适用于广泛的应用程序。有很多用户需要登录下载网站,等我们去采集。还没用的朋友还在等什么?立即试用:QQWorld 采集器。 查看全部

自动采集网站内容(本篇文章我教大家如何获取Cookies登录状态是通过Cookies判定的)

在这篇文章中文章我教你如何采集需要登录网站并自动下载其资源。

获取 Cookie

登录状态由Cookies决定,所以先登录目标网站,按F12打开开发者工具,将Cookies复制到剪贴板如下图。

https://www.qqworld.org/wp-con ... 0.png 300w, https://www.qqworld.org/wp-con ... 1.png 768w, https://www.qqworld.org/wp-con ... s.png 1055w" />

https://www.qqworld.org/wp-con ... 0.png 300w, https://www.qqworld.org/wp-con ... 1.png 768w, https://www.qqworld.org/wp-con ... s.png 1055w" />然后在QQWorld采集器的采集品中新建一个,将复制的Cookies代码粘贴到Cookies输入框中:

https://www.qqworld.org/wp-con ... 7.png 300w, https://www.qqworld.org/wp-con ... 6.png 768w" />

https://www.qqworld.org/wp-con ... 7.png 300w, https://www.qqworld.org/wp-con ... 6.png 768w" />设置采集rule 常规设置

设置采集 列表链接、文章 标题和文章 内容选择器。这些都比较简单,这里不再赘述。不明白的请参考QQWorld采集器旗舰采集教程。

采集download 资源

因为填充了cookies,所以在爬取的网页内容中可以看到下载地址的代码,如图:

https://www.qqworld.org/wp-con ... 3.png 300w" />

https://www.qqworld.org/wp-con ... 3.png 300w" />因为onclick属性中有多余的代码,只用引号括起来的内容就够了,所以要使用正则表达式采集,新建一个自定义列采集,设置方法如图图:

https://www.qqworld.org/wp-con ... 3.png 300w, https://www.qqworld.org/wp-con ... 5.png 768w, https://www.qqworld.org/wp-con ... t.png 1375w" />

https://www.qqworld.org/wp-con ... 3.png 300w, https://www.qqworld.org/wp-con ... 5.png 768w, https://www.qqworld.org/wp-con ... t.png 1375w" />这里设置下载地址保存在win-down自定义列中,由于采集到达的地址是相对地址,需要根据完整地址加前缀。然后检查下载到本地目录。也可以勾选下载到媒体库,但首先要确保Wordpress媒体库允许上传这种格式。

格式文章content

大部分用户不会修改模板,所以不知道如何输出这个下载地址。 QQWorld 采集器提供文章content 格式化工具。在采集项的自动采集设置中,如下图设置:

https://www.qqworld.org/wp-con ... 0.png 300w, https://www.qqworld.org/wp-con ... 5.png 768w" />

https://www.qqworld.org/wp-con ... 0.png 300w, https://www.qqworld.org/wp-con ... 5.png 768w" />可以使用四个短代码,分别代表文章content、文章title、文章custom 列和超链接。在自定义列简码的key属性中填写win-down输出下载地址。

结论

遗憾的是,需要付费的内容不能是采集。没有办法做到这一点。

教程到此结束。此功能应适用于广泛的应用程序。有很多用户需要登录下载网站,等我们去采集。还没用的朋友还在等什么?立即试用:QQWorld 采集器。

自动采集网站内容(自动采集网站内容的网站有不少,怎么办?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-08-29 15:02

自动采集网站内容的网站有不少,我目前知道的包括站长之家,众成翻译,西瓜翻译等等。如果你要自己采集网站内容,那就需要多研究网站,每天上去看看信息的更新,可以做一些标注和记录。如果是需要免费网站内容的话,那有一个叫谷歌翻译的网站可以免费帮助你。当然,请花费些时间去辨别和判断下。

我们可以做一个网站专门去找翻译,数量不多,1.2w左右。

考虑语言方面的多一些,

百度的网站爬虫有时抓取不了,就是这么麻烦,我们目前可以从百度搜索引擎获取到10.6万篇来自全球各地的文章!有需要的话可以私信我。

google翻译吧,用着比较简单,这也是我们网站去搬砖的主要工具。也是仅有的一个可以把大量外文文章翻译成中文的网站。

freeextractor

外网翻译网,可以把国外网站翻译成中文,

你可以搜索一下附近有没有机构做谷歌翻译,不过应该是花钱去买的,如果没有免费的机构,我估计没几个能把内容全部翻译出来。

transferwise还有transferwiseyahoo

专业办事情的网站,阿拉丁网,你可以搜一下,

国内现在没有免费的渠道这种啊,我目前正在做翻译网站,

突然想起来原来还有做机器翻译的方法。国内也有很多机器翻译的接口,不过你就需要通过cnki来寻找需要翻译的内容,如果没有相关的期刊论文,至少还是国外的review的内容吧。cnki上一般也是有单独的翻译口径库,就是翻译几个字对原文或者说更高级的意思来说都可以,然后一种意思翻译出来对应一种语言,所以不影响意思。

除了国内的一些平台,我最近想到如果放到googleplay上面去进行测试也可以检测你想要的翻译信息,只不过测试的有点远,你可以自己试试这个方法。不过我感觉即使这样也应该不容易吧翻译本身就是需要一定的语言基础知识的,不是所有的词都可以把对应的语言放在对应的位置翻译的吧。 查看全部

自动采集网站内容(自动采集网站内容的网站有不少,怎么办?)

自动采集网站内容的网站有不少,我目前知道的包括站长之家,众成翻译,西瓜翻译等等。如果你要自己采集网站内容,那就需要多研究网站,每天上去看看信息的更新,可以做一些标注和记录。如果是需要免费网站内容的话,那有一个叫谷歌翻译的网站可以免费帮助你。当然,请花费些时间去辨别和判断下。

我们可以做一个网站专门去找翻译,数量不多,1.2w左右。

考虑语言方面的多一些,

百度的网站爬虫有时抓取不了,就是这么麻烦,我们目前可以从百度搜索引擎获取到10.6万篇来自全球各地的文章!有需要的话可以私信我。

google翻译吧,用着比较简单,这也是我们网站去搬砖的主要工具。也是仅有的一个可以把大量外文文章翻译成中文的网站。

freeextractor

外网翻译网,可以把国外网站翻译成中文,

你可以搜索一下附近有没有机构做谷歌翻译,不过应该是花钱去买的,如果没有免费的机构,我估计没几个能把内容全部翻译出来。

transferwise还有transferwiseyahoo

专业办事情的网站,阿拉丁网,你可以搜一下,

国内现在没有免费的渠道这种啊,我目前正在做翻译网站,

突然想起来原来还有做机器翻译的方法。国内也有很多机器翻译的接口,不过你就需要通过cnki来寻找需要翻译的内容,如果没有相关的期刊论文,至少还是国外的review的内容吧。cnki上一般也是有单独的翻译口径库,就是翻译几个字对原文或者说更高级的意思来说都可以,然后一种意思翻译出来对应一种语言,所以不影响意思。

除了国内的一些平台,我最近想到如果放到googleplay上面去进行测试也可以检测你想要的翻译信息,只不过测试的有点远,你可以自己试试这个方法。不过我感觉即使这样也应该不容易吧翻译本身就是需要一定的语言基础知识的,不是所有的词都可以把对应的语言放在对应的位置翻译的吧。

自动采集网站内容(网站抓取)已经不是什么新鲜事情了

采集交流 • 优采云 发表了文章 • 0 个评论 • 247 次浏览 • 2021-08-26 20:05

自动采集网站内容(网站抓取)已经不是什么新鲜事情了,自动采集的本质就是无人值守采集,使用了网络爬虫技术,在将网站内容进行处理后按照编辑好的模板生成网站报告,通过分析网站报告的结构是否对其进行重新生成,最终生成可导出表格的表格。没错,这就是网站采集。有网友开玩笑说,可以少去两趟厕所、少点两碗外卖,以后就能少搬家。

所以它被称为优采云采集器。除了上述的主要功能之外,它还存在不少不足之处。一,采集速度慢。是因为自动采集技术只能抓取网站中所有的文本页面,所以即使采集完成后,生成的网站报告中未添加你想要的各类关键词,也会显示“目前还未添加关键词”。二,关键词密度高。你会发现,不少网站关键词密度极高,即使是重复的内容都可以采集过来。

就像上面说的,这里的这个问题它也解决不了。三,定位不准。虽然自动采集有各类分词定位功能,可以按照关键词定位,定位方式分成“词类定位”和“关键词定位”。但其定位不准不完整,因为通过分词功能无法分辨出每个词性到底是什么。四,整体结构问题。自动采集器每一步都要对内容进行采集和数据分析,但就像你平时做数学卷子或完成的语文阅读理解一样,卷子的排版是固定的,比如上面是1-500,那你总不能一个都写吧,你就把500个词一个个写进去就行了。

通过这个问题就能发现它的问题了,那就是整体结构,就像你做数学卷子或完成的语文阅读理解,排版是固定的,比如上面是1-500,那你总不能一个都写吧,你就把500个词一个个写进去就行了。结果是怎样的呢?1,能采集的内容类型太少。比如采集漫画,相信2个月前你可能还能看到这样的情况。但是没想到,现在的你,看到这样的情况就很糟糕了。

毕竟你能看到大部分没有关键词的页面了。因为自动采集的网站主要针对的都是比较基础的网站内容,页面文本量相对较少,对应的采集速度相对快。所以你只需要把那些关键词和页面整理一下,再整理一下就行了。2,采集框定位方式存在不小的问题。比如像wps这样的文档类网站,采集整理页面,就没法用自动采集了,因为不能提取页面的关键词。

关键词按照上面的分类肯定是和其他页面有区别的,于是乎,自动采集把你的编辑好的文本结构数据与文本库中的数据对应起来。所以有些文章整个页面就没有关键词,它也没办法采集。这就是为什么相对于按关键词采集,自动采集有它独特的优势,但也有它的局限。所以今天我们重点讲一下,如何打破自动采集思维局限。这是这篇文章所要教给大家的核心内容,希望大家认真阅读。1,明确核心内容。不管是爬虫,还。 查看全部

自动采集网站内容(网站抓取)已经不是什么新鲜事情了

自动采集网站内容(网站抓取)已经不是什么新鲜事情了,自动采集的本质就是无人值守采集,使用了网络爬虫技术,在将网站内容进行处理后按照编辑好的模板生成网站报告,通过分析网站报告的结构是否对其进行重新生成,最终生成可导出表格的表格。没错,这就是网站采集。有网友开玩笑说,可以少去两趟厕所、少点两碗外卖,以后就能少搬家。

所以它被称为优采云采集器。除了上述的主要功能之外,它还存在不少不足之处。一,采集速度慢。是因为自动采集技术只能抓取网站中所有的文本页面,所以即使采集完成后,生成的网站报告中未添加你想要的各类关键词,也会显示“目前还未添加关键词”。二,关键词密度高。你会发现,不少网站关键词密度极高,即使是重复的内容都可以采集过来。

就像上面说的,这里的这个问题它也解决不了。三,定位不准。虽然自动采集有各类分词定位功能,可以按照关键词定位,定位方式分成“词类定位”和“关键词定位”。但其定位不准不完整,因为通过分词功能无法分辨出每个词性到底是什么。四,整体结构问题。自动采集器每一步都要对内容进行采集和数据分析,但就像你平时做数学卷子或完成的语文阅读理解一样,卷子的排版是固定的,比如上面是1-500,那你总不能一个都写吧,你就把500个词一个个写进去就行了。

通过这个问题就能发现它的问题了,那就是整体结构,就像你做数学卷子或完成的语文阅读理解,排版是固定的,比如上面是1-500,那你总不能一个都写吧,你就把500个词一个个写进去就行了。结果是怎样的呢?1,能采集的内容类型太少。比如采集漫画,相信2个月前你可能还能看到这样的情况。但是没想到,现在的你,看到这样的情况就很糟糕了。

毕竟你能看到大部分没有关键词的页面了。因为自动采集的网站主要针对的都是比较基础的网站内容,页面文本量相对较少,对应的采集速度相对快。所以你只需要把那些关键词和页面整理一下,再整理一下就行了。2,采集框定位方式存在不小的问题。比如像wps这样的文档类网站,采集整理页面,就没法用自动采集了,因为不能提取页面的关键词。

关键词按照上面的分类肯定是和其他页面有区别的,于是乎,自动采集把你的编辑好的文本结构数据与文本库中的数据对应起来。所以有些文章整个页面就没有关键词,它也没办法采集。这就是为什么相对于按关键词采集,自动采集有它独特的优势,但也有它的局限。所以今天我们重点讲一下,如何打破自动采集思维局限。这是这篇文章所要教给大家的核心内容,希望大家认真阅读。1,明确核心内容。不管是爬虫,还。

网络爬虫系统的原理和工作流程及注意事项介绍-乐题库

采集交流 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2021-08-25 02:02

网络数据采集是指通过网络爬虫或网站公共API从网站获取数据信息。这种方法可以从网页中提取非结构化数据,将其存储为统一的本地数据文件,并以结构化的方式存储。支持采集图片、音频、视频等文件或附件,可自动关联附件和文字。

在互联网时代,网络爬虫主要为搜索引擎提供最全面、最新的数据。

在大数据时代,网络爬虫更是互联网上采集data 的实用工具。已知的各种网络爬虫工具有数百种,网络爬虫工具基本上可以分为三类。

本节首先简要介绍网络爬虫的原理和工作流程,然后讨论网络爬虫的爬取策略,最后介绍典型的网络工具。网络爬虫的原理网络爬虫是根据一定的规则自动抓取网络信息的程序或脚本。

网络爬虫可以自动采集所有可以访问的页面内容,为搜索引擎和大数据分析提供数据源。就功能而言,爬虫一般具有数据采集、处理和存储三个功能,如图1所示。

图 1 网络爬虫示意图

网页中除了供用户阅读的文字信息外,还收录一些超链接信息。

网络爬虫系统通过网页中的超链接信息不断获取互联网上的其他网页。网络爬虫从一个或几个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,不断地从当前页面中提取新的URL并将其放入队列中,直到满足系统的某个停止条件。

网络爬虫系统一般会选择一些比较重要的网站 URL,外展度(网页中超链接的数量)较高作为种子URL集合。

网络爬虫系统使用这些种子集合作为初始 URL 来开始数据爬取。由于网页收录链接信息,所以会通过现有网页的网址获取一些新的网址。

网页之间的指向结构可以看成是一片森林,每个种子URL对应的网页就是森林中一棵树的根节点,这样网络爬虫系统就可以按照广度优先搜索算法进行搜索或者深度优先搜索算法遍历所有网页。

因为深度优先搜索算法可能会导致爬虫系统陷入网站内部,不利于搜索更接近网站首页的网页信息,所以广度优先搜索算法采集页一般使用。

网络爬虫系统首先将种子URL放入下载队列,简单地从队列头部取出一个URL下载对应的网页,获取网页内容并存储,解析链接后网页中的信息,你可以得到一些新的网址。

其次,根据一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,放入URL队列等待抓取。

最后,取出一个URL,下载其对应的网页,然后解析,不断重复,直到遍历全网或满足一定条件。网络爬虫的工作流程如图2所示。网络爬虫的基本工作流程如下。

1) 首先选择种子 URL 的一部分。

2) 将这些 URL 放入 URL 队列进行抓取。

3)从待爬取的URL队列中取出待爬取的URL,解析DNS得到主机的IP地址,下载该URL对应的网页并存储在下载的web中页库。另外,将这些网址放入抓取到的网址队列中。

4)对爬取的URL队列中的URL进行分析,分析其中的其他URL,将这些URL放入URL队列进行爬取,从而进入下一个循环。

图 2 网络爬虫的基本工作流程

Web Crawler 抓取策略 Google、百度等通用搜索引擎抓取的网页数量通常以亿为单位计算。那么,面对如此多的网页,网络爬虫如何才能尽可能的遍历所有网页,从而尽可能扩大网页信息的覆盖范围呢?这是网络爬虫系统面临的一个非常关键的问题。在网络爬虫系统中,抓取策略决定了抓取网页的顺序。

本节首先简单介绍一下网络爬虫的爬取策略中用到的基本概念。 1)网页之间的关系模型从互联网的结构来看,网页之间通过数量不等的超链接相互连接,形成一个庞大而复杂的有向图,相互关联。

如图3所示,如果一个网页被视为图中的某个节点,而该网页中其他网页的链接被视为该节点到其他节点的边,那么我们可以很容易地认为整个网页Internet 上的页面被建模为有向图。

理论上,通过遍历算法遍历图,几乎可以访问互联网上的所有网页。

图 3 网页关系模型图

2)网页分类从爬虫的角度划分互联网。互联网上的所有页面可以分为5个部分:已下载和未过期网页、已下载和已过期网页、可下载网页、已知网页和不可知网页网页,如图4所示。

抓取的本地网页实际上是互联网内容的镜像和备份。互联网是动态变化的。当互联网上的部分内容发生变化时,抓取到的本地网页就会失效。因此,下载的网页分为两种:下载的未过期网页和下载的过期网页。

图 4 网页分类

待下载的网页是指在URL队列中待抓取的页面。

可以看出,网页指的是未被抓取的网页,也不在待抓取的URL队列中,但可以通过分析抓取的页面或要抓取的URL对应的页面获取已抓取。

还有一些网页是网络爬虫无法直接抓取下载的,称为不可知网页。

以下重点介绍几种常见的抓取策略。 1. 万能网络爬虫 万能网络爬虫又称全网爬虫。爬取对象从一些种子网址扩展到整个Web,主要是门户搜索引擎和大型Web服务提供商采集data。

为了提高工作效率,一般的网络爬虫都会采用一定的爬取策略。常用的爬取策略包括深度优先策略和广度优先策略。

1)深度优先策略

深度优先策略是指网络爬虫会从起始页开始,逐个跟踪链接,直到无法再深入。

网络爬虫在完成一个爬行分支后返回上一个链接节点,进一步搜索其他链接。当所有链接都遍历完后,爬取任务结束。

此策略更适合垂直搜索或站点搜索,但在抓取页面内容更深层次的站点时会造成资源的巨大浪费。

以图3为例,遍历的路径为1→2→5→6→3→7→4→8。

在深度优先策略中,当搜索到某个节点时,该节点的子节点和子节点的后继节点都优先于该节点的兄弟节点。深度优先策略是在搜索空间的时候,会尽可能的深入,只有在找不到一个节点的后继节点时才考虑它的兄弟节点。

这样的策略决定了深度优先策略不一定能找到最优解,甚至由于深度的限制而无法找到解。

如果没有限制,它会沿着一条路径无限扩展,从而“陷入”海量数据。一般情况下,使用深度优先策略会选择一个合适的深度,然后反复搜索直到找到一个解,这样就降低了搜索的效率。因此,当搜索数据量较小时,一般采用深度优先策略。

2)广度优先策略

广度优先策略根据网页内容目录的深度抓取网页。首先抓取较浅目录级别的页面。当同一级别的页面被爬取时,爬虫会进入下一层继续爬取。

仍以图3为例,遍历路径为1→2→3→4→5→6→7→8

因为广度优先策略是在第N层节点扩展完成后进入第N+1层,所以可以保证找到路径最短的解。

该策略可以有效控制页面的爬取深度,避免遇到无限深分支无法结束爬取的问题,实现方便,无需存储大量中间节点。缺点是爬到目录需要很长时间。更深的页面。

如果搜索过程中分支过多,即节点的后继节点过多,算法就会耗尽资源,在可用空间中找不到解。 2.专注于网络爬虫专注于网络爬虫,也称为主题网络爬虫,是指选择性抓取与预定义主题相关的页面的网络爬虫。

1)基于内容评价的爬取策略

DeBra 将文本相似度的计算方法引入到网络爬虫中,并提出了 Fish Search 算法。

算法以用户输入的查询词为主题,将收录查询词的页面视为主题相关页面。它的局限性在于它无法评估页面与主题的相关性。

Herseovic 改进了 Fish Search 算法,提出了 Shark Search 算法,该算法使用空间向量模型来计算页面与主题的相关性。

使用基于连续值计算链接值的方法,不仅可以计算出哪些抓取的链接与主题相关,还可以量化相关性的大小。

2)基于链接结构评估的爬行策略

网页不同于一般文本。它是一个收录大量结构化信息的半结构化文档。

网页不是单独存在的。页面上的链接表示页面之间的相互关系。基于链接结构的搜索策略模型利用这些结构特征来评估页面和链接的重要性来确定搜索顺序。其中,PageRank算法是这类搜索策略模型的代表。

PageRank 算法的基本原理是,如果一个网页被多次引用,它可能是一个非常重要的网页。如果一个网页没有被多次引用,但被一个重要的网页引用,那么它也可能是一个重要的网页。一个网页的重要性均匀地传递给它所引用的网页。

将某个页面的PageRank除以该页面上存在的前向链接,并将得到的值与前向链接指向的页面的PageRank相加,得到被链接页面的PageRank .

如图 5 所示,PageRank 值为 100 的网页将其重要性平均转移到它引用的两个页面上,每个页面得到 50。同样,PageRank 值为 9 的网页引用它为 3 个页面中的每个页面传递的值是 3。

PageRank 值为 53 的页面的值来自引用它的两个页面传递的值。

,

图 5 PageRank 算法示例

3) 基于强化学习的爬行策略

Rennie 和 McCallum 将增强学习引入聚焦爬虫,使用贝叶斯分类器根据整个网页文本和链接文本对超链接进行分类,并计算每个链接的重要性,从而确定链接访问的顺序。

4)基于上下文映射的爬行策略

Diligenti 等人。提出了一种爬行策略,通过建立上下文映射来学习网页之间的相关性。该策略可以训练一个机器学习系统,通过该系统可以计算当前页面和相关网页之间的距离。首先访问最近页面中的链接。 3.增量网络爬虫增量网络爬虫是指对下载的网页进行增量更新,只抓取新生成或变化的网页的爬虫。可以在一定程度上保证抓取到的页面尽可能是新页面。

增量网络爬虫有两个目标:

为了实现第一个目标,增量网络爬虫需要重新访问网页以更新本地页面集中页面的内容。常用的方法有统一更新法、个体更新法和基于分类的更新法。

为了实现第二个目标,增量网络爬虫需要对网页的重要性进行排名。常见的策略有广度优先策略、PageRank优先策略等。4.深网爬虫网页根据存在方式可分为表层网页和深层网页。

深网爬虫架构包括6个基本功能模块(爬虫控制器、解析器、表单分析器、表单处理器、响应分析器、LVS控制器)和两个爬虫内部数据结构(URL列表和LVS表)。

其中,LVS(LabelValueSet)表示标签和值的集合,用于表示填写表单的数据源。在爬虫过程中,最重要的部分是表单填写,包括基于领域知识的表单填写和基于网页结构分析的表单填写。 查看全部

网络爬虫系统的原理和工作流程及注意事项介绍-乐题库

网络数据采集是指通过网络爬虫或网站公共API从网站获取数据信息。这种方法可以从网页中提取非结构化数据,将其存储为统一的本地数据文件,并以结构化的方式存储。支持采集图片、音频、视频等文件或附件,可自动关联附件和文字。

在互联网时代,网络爬虫主要为搜索引擎提供最全面、最新的数据。

在大数据时代,网络爬虫更是互联网上采集data 的实用工具。已知的各种网络爬虫工具有数百种,网络爬虫工具基本上可以分为三类。

本节首先简要介绍网络爬虫的原理和工作流程,然后讨论网络爬虫的爬取策略,最后介绍典型的网络工具。网络爬虫的原理网络爬虫是根据一定的规则自动抓取网络信息的程序或脚本。

网络爬虫可以自动采集所有可以访问的页面内容,为搜索引擎和大数据分析提供数据源。就功能而言,爬虫一般具有数据采集、处理和存储三个功能,如图1所示。

图 1 网络爬虫示意图

网页中除了供用户阅读的文字信息外,还收录一些超链接信息。

网络爬虫系统通过网页中的超链接信息不断获取互联网上的其他网页。网络爬虫从一个或几个初始网页的URL开始,获取初始网页上的URL。在抓取网页的过程中,不断地从当前页面中提取新的URL并将其放入队列中,直到满足系统的某个停止条件。

网络爬虫系统一般会选择一些比较重要的网站 URL,外展度(网页中超链接的数量)较高作为种子URL集合。

网络爬虫系统使用这些种子集合作为初始 URL 来开始数据爬取。由于网页收录链接信息,所以会通过现有网页的网址获取一些新的网址。

网页之间的指向结构可以看成是一片森林,每个种子URL对应的网页就是森林中一棵树的根节点,这样网络爬虫系统就可以按照广度优先搜索算法进行搜索或者深度优先搜索算法遍历所有网页。

因为深度优先搜索算法可能会导致爬虫系统陷入网站内部,不利于搜索更接近网站首页的网页信息,所以广度优先搜索算法采集页一般使用。

网络爬虫系统首先将种子URL放入下载队列,简单地从队列头部取出一个URL下载对应的网页,获取网页内容并存储,解析链接后网页中的信息,你可以得到一些新的网址。

其次,根据一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,放入URL队列等待抓取。

最后,取出一个URL,下载其对应的网页,然后解析,不断重复,直到遍历全网或满足一定条件。网络爬虫的工作流程如图2所示。网络爬虫的基本工作流程如下。

1) 首先选择种子 URL 的一部分。

2) 将这些 URL 放入 URL 队列进行抓取。

3)从待爬取的URL队列中取出待爬取的URL,解析DNS得到主机的IP地址,下载该URL对应的网页并存储在下载的web中页库。另外,将这些网址放入抓取到的网址队列中。

4)对爬取的URL队列中的URL进行分析,分析其中的其他URL,将这些URL放入URL队列进行爬取,从而进入下一个循环。

图 2 网络爬虫的基本工作流程

Web Crawler 抓取策略 Google、百度等通用搜索引擎抓取的网页数量通常以亿为单位计算。那么,面对如此多的网页,网络爬虫如何才能尽可能的遍历所有网页,从而尽可能扩大网页信息的覆盖范围呢?这是网络爬虫系统面临的一个非常关键的问题。在网络爬虫系统中,抓取策略决定了抓取网页的顺序。

本节首先简单介绍一下网络爬虫的爬取策略中用到的基本概念。 1)网页之间的关系模型从互联网的结构来看,网页之间通过数量不等的超链接相互连接,形成一个庞大而复杂的有向图,相互关联。

如图3所示,如果一个网页被视为图中的某个节点,而该网页中其他网页的链接被视为该节点到其他节点的边,那么我们可以很容易地认为整个网页Internet 上的页面被建模为有向图。

理论上,通过遍历算法遍历图,几乎可以访问互联网上的所有网页。

图 3 网页关系模型图

2)网页分类从爬虫的角度划分互联网。互联网上的所有页面可以分为5个部分:已下载和未过期网页、已下载和已过期网页、可下载网页、已知网页和不可知网页网页,如图4所示。

抓取的本地网页实际上是互联网内容的镜像和备份。互联网是动态变化的。当互联网上的部分内容发生变化时,抓取到的本地网页就会失效。因此,下载的网页分为两种:下载的未过期网页和下载的过期网页。

图 4 网页分类

待下载的网页是指在URL队列中待抓取的页面。

可以看出,网页指的是未被抓取的网页,也不在待抓取的URL队列中,但可以通过分析抓取的页面或要抓取的URL对应的页面获取已抓取。

还有一些网页是网络爬虫无法直接抓取下载的,称为不可知网页。

以下重点介绍几种常见的抓取策略。 1. 万能网络爬虫 万能网络爬虫又称全网爬虫。爬取对象从一些种子网址扩展到整个Web,主要是门户搜索引擎和大型Web服务提供商采集data。

为了提高工作效率,一般的网络爬虫都会采用一定的爬取策略。常用的爬取策略包括深度优先策略和广度优先策略。

1)深度优先策略

深度优先策略是指网络爬虫会从起始页开始,逐个跟踪链接,直到无法再深入。

网络爬虫在完成一个爬行分支后返回上一个链接节点,进一步搜索其他链接。当所有链接都遍历完后,爬取任务结束。

此策略更适合垂直搜索或站点搜索,但在抓取页面内容更深层次的站点时会造成资源的巨大浪费。

以图3为例,遍历的路径为1→2→5→6→3→7→4→8。

在深度优先策略中,当搜索到某个节点时,该节点的子节点和子节点的后继节点都优先于该节点的兄弟节点。深度优先策略是在搜索空间的时候,会尽可能的深入,只有在找不到一个节点的后继节点时才考虑它的兄弟节点。

这样的策略决定了深度优先策略不一定能找到最优解,甚至由于深度的限制而无法找到解。

如果没有限制,它会沿着一条路径无限扩展,从而“陷入”海量数据。一般情况下,使用深度优先策略会选择一个合适的深度,然后反复搜索直到找到一个解,这样就降低了搜索的效率。因此,当搜索数据量较小时,一般采用深度优先策略。

2)广度优先策略

广度优先策略根据网页内容目录的深度抓取网页。首先抓取较浅目录级别的页面。当同一级别的页面被爬取时,爬虫会进入下一层继续爬取。

仍以图3为例,遍历路径为1→2→3→4→5→6→7→8

因为广度优先策略是在第N层节点扩展完成后进入第N+1层,所以可以保证找到路径最短的解。

该策略可以有效控制页面的爬取深度,避免遇到无限深分支无法结束爬取的问题,实现方便,无需存储大量中间节点。缺点是爬到目录需要很长时间。更深的页面。

如果搜索过程中分支过多,即节点的后继节点过多,算法就会耗尽资源,在可用空间中找不到解。 2.专注于网络爬虫专注于网络爬虫,也称为主题网络爬虫,是指选择性抓取与预定义主题相关的页面的网络爬虫。

1)基于内容评价的爬取策略

DeBra 将文本相似度的计算方法引入到网络爬虫中,并提出了 Fish Search 算法。

算法以用户输入的查询词为主题,将收录查询词的页面视为主题相关页面。它的局限性在于它无法评估页面与主题的相关性。

Herseovic 改进了 Fish Search 算法,提出了 Shark Search 算法,该算法使用空间向量模型来计算页面与主题的相关性。

使用基于连续值计算链接值的方法,不仅可以计算出哪些抓取的链接与主题相关,还可以量化相关性的大小。

2)基于链接结构评估的爬行策略

网页不同于一般文本。它是一个收录大量结构化信息的半结构化文档。

网页不是单独存在的。页面上的链接表示页面之间的相互关系。基于链接结构的搜索策略模型利用这些结构特征来评估页面和链接的重要性来确定搜索顺序。其中,PageRank算法是这类搜索策略模型的代表。

PageRank 算法的基本原理是,如果一个网页被多次引用,它可能是一个非常重要的网页。如果一个网页没有被多次引用,但被一个重要的网页引用,那么它也可能是一个重要的网页。一个网页的重要性均匀地传递给它所引用的网页。

将某个页面的PageRank除以该页面上存在的前向链接,并将得到的值与前向链接指向的页面的PageRank相加,得到被链接页面的PageRank .

如图 5 所示,PageRank 值为 100 的网页将其重要性平均转移到它引用的两个页面上,每个页面得到 50。同样,PageRank 值为 9 的网页引用它为 3 个页面中的每个页面传递的值是 3。

PageRank 值为 53 的页面的值来自引用它的两个页面传递的值。

,

图 5 PageRank 算法示例

3) 基于强化学习的爬行策略

Rennie 和 McCallum 将增强学习引入聚焦爬虫,使用贝叶斯分类器根据整个网页文本和链接文本对超链接进行分类,并计算每个链接的重要性,从而确定链接访问的顺序。

4)基于上下文映射的爬行策略

Diligenti 等人。提出了一种爬行策略,通过建立上下文映射来学习网页之间的相关性。该策略可以训练一个机器学习系统,通过该系统可以计算当前页面和相关网页之间的距离。首先访问最近页面中的链接。 3.增量网络爬虫增量网络爬虫是指对下载的网页进行增量更新,只抓取新生成或变化的网页的爬虫。可以在一定程度上保证抓取到的页面尽可能是新页面。

增量网络爬虫有两个目标:

为了实现第一个目标,增量网络爬虫需要重新访问网页以更新本地页面集中页面的内容。常用的方法有统一更新法、个体更新法和基于分类的更新法。

为了实现第二个目标,增量网络爬虫需要对网页的重要性进行排名。常见的策略有广度优先策略、PageRank优先策略等。4.深网爬虫网页根据存在方式可分为表层网页和深层网页。

深网爬虫架构包括6个基本功能模块(爬虫控制器、解析器、表单分析器、表单处理器、响应分析器、LVS控制器)和两个爬虫内部数据结构(URL列表和LVS表)。

其中,LVS(LabelValueSet)表示标签和值的集合,用于表示填写表单的数据源。在爬虫过程中,最重要的部分是表单填写,包括基于领域知识的表单填写和基于网页结构分析的表单填写。

WP采集专家详解:WordPress采集工具的功能特点及设置

采集交流 • 优采云 发表了文章 • 0 个评论 • 210 次浏览 • 2021-08-25 01:12

WP采集专家是一款模仿AutoPost的WordPress采集工具。它可以是采集any网站content。 采集 过程完全自动化,无需人工干预。它使用起来非常简单,不需要复杂的设置。而且它足够强大和稳定。

[特点]

1)使用客户端运行,不占用服务器资源,速度快。

2) 完全免费且无限制。

限制:

1)要求服务器支持MYSQL远程登录。

2)还在逐步更新中,功能没有AutoPost那么强大。

[软件功能]

可以采集任意网站内容,采集信息一目了然

任务开启后会自动更新采集,无需人工调度

到采集,支持通配符匹配,或者CSS选择器精确采集any内容,支持采集multi-level文章list,支持采集body分页内容,支持采集multi-级别正文内容

基础设置齐全,完美支持Wordpress各种功能

[使用说明]

系统设置:输入服务器、端口、用户名、密码、数据库、WP头

主界面:添加采集task,复制采集task

采集设置:

基本设置-名称、作者、分类、编码

采集 URL-起始页、列表页、文章页

文章设置-标题开始标签、标题结束标志、文章开始标签、结束标签文化、添加转载声明

文章到采集的列表:点击“标题”访问本站文章,点击“来源网址”访问“来源网址”,一些垃圾文章可以单独删除。

删除功能:可以删除一些垃圾任务和文章。 查看全部

WP采集专家详解:WordPress采集工具的功能特点及设置

WP采集专家是一款模仿AutoPost的WordPress采集工具。它可以是采集any网站content。 采集 过程完全自动化,无需人工干预。它使用起来非常简单,不需要复杂的设置。而且它足够强大和稳定。

[特点]

1)使用客户端运行,不占用服务器资源,速度快。

2) 完全免费且无限制。

限制:

1)要求服务器支持MYSQL远程登录。

2)还在逐步更新中,功能没有AutoPost那么强大。

[软件功能]

可以采集任意网站内容,采集信息一目了然

任务开启后会自动更新采集,无需人工调度

到采集,支持通配符匹配,或者CSS选择器精确采集any内容,支持采集multi-level文章list,支持采集body分页内容,支持采集multi-级别正文内容

基础设置齐全,完美支持Wordpress各种功能

[使用说明]

系统设置:输入服务器、端口、用户名、密码、数据库、WP头

主界面:添加采集task,复制采集task

采集设置:

基本设置-名称、作者、分类、编码

采集 URL-起始页、列表页、文章页

文章设置-标题开始标签、标题结束标志、文章开始标签、结束标签文化、添加转载声明

文章到采集的列表:点击“标题”访问本站文章,点击“来源网址”访问“来源网址”,一些垃圾文章可以单独删除。

删除功能:可以删除一些垃圾任务和文章。

优采云采集器功能介绍简单来讲,完全傻瓜式操作适合所有人

采集交流 • 优采云 发表了文章 • 0 个评论 • 170 次浏览 • 2021-08-25 01:11

优采云采集器功能介绍简单来讲,完全傻瓜式操作适合所有人

优采云采集器,这是一款专业高效的data采集软件,可以将采集各类网站中的数据快速导出和保存,支持图形识别,定时采集和其他功能,全傻瓜式操作,适合所有人!

优采云采集器软件介绍

优采云采集器是一款功能强大的网页数据采集软件,使用非常简单,可以在短时间内从各种网页中获取大量数据,摆脱人工搜索和数据采集。依赖,降低获取信息的成本,从而提高效率。完美软件站提供优采云采集器免费下载。

优采云采集器功能介绍

简单来说,使用优采云可以轻松地从任何网页生成自定义的常规数据格式,以准确采集您需要的数据。 优采云数据采集系统能做的包括但不限于以下内容:

财务数据,如季报、年报、财报,包括每日最新净值自动采集;各大新闻门户网站实时监控,自动更新上传最新新闻;监控竞争对手的最新信息,包括商品价格和库存;监控各大社交网络网站、博客,自动抓取企业产品相关评论;采集最新最全面的招聘信息;监控各大楼盘相关网站,采集新房二房最新行情;采集一平台发布,其他平台自动更新。 优采云采集器软件功能

1、操作简单

操作简单,图形操作完全可视化,无需专业IT人员,任何会电脑上网的人都可以轻松掌握。

2、云采集

采集任务自动分发到云端多台服务器同时执行,提高了采集的效率,短时间内可以获得数千条信息。

3、drag and drop采集process

模仿人类的操作思维方式,可以登录、输入数据、点击链接、按钮等,也可以针对不同的情况采用不同的采集流程。

4、图形识别

内置可扩展OCR接口,支持解析图片中的文字,提取图片上的文字。

5、timing automatic采集

采集任务自动运行,可以按照指定周期自动采集,同时支持实时采集,最快一分钟一次。

6、2 分钟快速入门

内置从入门到精通的视频教程,2分钟即可上手,还有文档、论坛、qq群等

7、免费使用

它是免费的,免费版没有功能限制。您可以立即试用,立即下载并安装。

优采云采集器安装说明

下载优采云网站数据采集器,解压压缩包,双击.exe文件,选择软件保存路径,点击【安装】,

安装软件,耐心等待,

软件安装完成后,点击运行。

优采云采集器如何使用

1、Activation优采云网站数据采集器,您需要登录后才能使用各项功能。可以直接点击【免费注册】按钮注册账号。

2、进入优采云软件页面后,点击【快速入门】=>【新建任务】打开新建任务界面

3、选择任务组(或新建任务组),输入任务名称和描述=>点击下一步

4、进入流程配置页面=>拖一步打开网页进入流程设计器

5、选择打开网页的步骤=>输入页面地址=>点击保存

接下来我们要配置采集规则,首先点击软件下的网页请求采集数据

6、之后会出现一个选择对话框,这里我们选择‘提取该元素的文本’

7、 这样系统会自己添加一个'提取数据'的步骤。这样,一个数据点的采集规则就设置好了,继续点击网页上其他需要采集的数据点,选择'提取该元素的文本',配置采集设置其他数据点。配置完所有数据点后,修改每个数据点的名称,这样采集进程就配置好了。

保存后点击下一步=>下一步=>选择检测任务

8、打开本地采集页面,点击启动按钮,启动本地采集,查看任务运行效果,进程运行后采集收到的数据会显示在界面最下方的表格,从表格中的数据可以看出,我们想要的数据已经成功采集down了。

这是单个网页最简单的采集整个流程。

安装过程中的常见问题

按照以上正常操作,优采云Windows 客户端无法安装?您可能会遇到以下问题:

1、安装过程中提示【安装已终止,安装程序未成功运行】

原因:之前安装过旧版本,没有卸载干净,还有残留。

解决方法①:删除优采云8缓存文件夹。找到\AppData\Roaming\Octopus8文件夹,删除Octopus8文件夹。

解决方法②:打开【控制面板】-【程序】,卸载之前安装的版本。

查看全部

优采云采集器功能介绍简单来讲,完全傻瓜式操作适合所有人

优采云采集器,这是一款专业高效的data采集软件,可以将采集各类网站中的数据快速导出和保存,支持图形识别,定时采集和其他功能,全傻瓜式操作,适合所有人!

优采云采集器软件介绍

优采云采集器是一款功能强大的网页数据采集软件,使用非常简单,可以在短时间内从各种网页中获取大量数据,摆脱人工搜索和数据采集。依赖,降低获取信息的成本,从而提高效率。完美软件站提供优采云采集器免费下载。

优采云采集器功能介绍

简单来说,使用优采云可以轻松地从任何网页生成自定义的常规数据格式,以准确采集您需要的数据。 优采云数据采集系统能做的包括但不限于以下内容:

财务数据,如季报、年报、财报,包括每日最新净值自动采集;各大新闻门户网站实时监控,自动更新上传最新新闻;监控竞争对手的最新信息,包括商品价格和库存;监控各大社交网络网站、博客,自动抓取企业产品相关评论;采集最新最全面的招聘信息;监控各大楼盘相关网站,采集新房二房最新行情;采集一平台发布,其他平台自动更新。 优采云采集器软件功能

1、操作简单

操作简单,图形操作完全可视化,无需专业IT人员,任何会电脑上网的人都可以轻松掌握。

2、云采集

采集任务自动分发到云端多台服务器同时执行,提高了采集的效率,短时间内可以获得数千条信息。

3、drag and drop采集process

模仿人类的操作思维方式,可以登录、输入数据、点击链接、按钮等,也可以针对不同的情况采用不同的采集流程。

4、图形识别

内置可扩展OCR接口,支持解析图片中的文字,提取图片上的文字。

5、timing automatic采集

采集任务自动运行,可以按照指定周期自动采集,同时支持实时采集,最快一分钟一次。

6、2 分钟快速入门

内置从入门到精通的视频教程,2分钟即可上手,还有文档、论坛、qq群等

7、免费使用

它是免费的,免费版没有功能限制。您可以立即试用,立即下载并安装。

优采云采集器安装说明

下载优采云网站数据采集器,解压压缩包,双击.exe文件,选择软件保存路径,点击【安装】,

安装软件,耐心等待,

软件安装完成后,点击运行。

优采云采集器如何使用

1、Activation优采云网站数据采集器,您需要登录后才能使用各项功能。可以直接点击【免费注册】按钮注册账号。

2、进入优采云软件页面后,点击【快速入门】=>【新建任务】打开新建任务界面

3、选择任务组(或新建任务组),输入任务名称和描述=>点击下一步

4、进入流程配置页面=>拖一步打开网页进入流程设计器

5、选择打开网页的步骤=>输入页面地址=>点击保存

接下来我们要配置采集规则,首先点击软件下的网页请求采集数据

6、之后会出现一个选择对话框,这里我们选择‘提取该元素的文本’

7、 这样系统会自己添加一个'提取数据'的步骤。这样,一个数据点的采集规则就设置好了,继续点击网页上其他需要采集的数据点,选择'提取该元素的文本',配置采集设置其他数据点。配置完所有数据点后,修改每个数据点的名称,这样采集进程就配置好了。

保存后点击下一步=>下一步=>选择检测任务

8、打开本地采集页面,点击启动按钮,启动本地采集,查看任务运行效果,进程运行后采集收到的数据会显示在界面最下方的表格,从表格中的数据可以看出,我们想要的数据已经成功采集down了。

这是单个网页最简单的采集整个流程。

安装过程中的常见问题

按照以上正常操作,优采云Windows 客户端无法安装?您可能会遇到以下问题:

1、安装过程中提示【安装已终止,安装程序未成功运行】

原因:之前安装过旧版本,没有卸载干净,还有残留。

解决方法①:删除优采云8缓存文件夹。找到\AppData\Roaming\Octopus8文件夹,删除Octopus8文件夹。

解决方法②:打开【控制面板】-【程序】,卸载之前安装的版本。

如何使用vue获取web应用内部的自定义根路径?

采集交流 • 优采云 发表了文章 • 0 个评论 • 253 次浏览 • 2021-08-15 19:03

自动采集网站内容的内容自动抓取网站链接:【网站聚合】为你快速聚合网站内容!:采集vue更多干货敬请关注/#/

推荐一个公众号【基于vue的前端团队合作】,开发的一个模块可以帮助你解决以下问题:如何利用vue获取web应用内部的自定义标签?如何利用vue获取web应用的根路径?如何利用vue获取web应用的组件路径?如何利用vue获取代码仓库/gitlab?如何利用vue获取web应用内部的根路径?如何使用rxjs自定义根路径?如何使用vue和vuex、flux、bootstrap等其他解决方案的集成?如何使用vue解决打包/打包分包/组件开发等问题?如何应用es6/vuex/es6exports等vuex特性?如何使用vue解决各种前端页面静态资源打包问题?vue的性能优化方案可以分为如下几个阶段:。

1)前端静态资源的拼接比如vue里面整个网页的静态资源使用一个ejs,ejs将静态资源分割为media-source-vue或者xml-source-vue文件(每个xml文件即是一个meta标签)。虽然vue在某些情况下不需要加载media-source-vue文件,但是如果后端apache写好页面内容后,需要再把静态资源(也就是media-source-vue)丢到前端页面去使用,这时候就需要用到vue的postcss特性或者由他人配置使用模板引擎生成静态资源。

2)vuex特性(重要)vuex的相关性能优化工作很多:vuex提供的store可以把后端apache中的静态资源拷贝到前端页面用作响应式页面,vuex中包含的component可以把后端apache中的静态资源拷贝到前端页面使用响应式的router对vue进行push/pull,或者通过vuex转换响应式路由。

3)vue-loader特性(重要)vue-loader打包vue中的exports,并且解决了vuex属性转换问题。

1)打包-高德es6-plugin

2)输出state-vue

3)component-vue在npm官网中,也有打包jsx或者modulexml等插件, 查看全部

如何使用vue获取web应用内部的自定义根路径?

自动采集网站内容的内容自动抓取网站链接:【网站聚合】为你快速聚合网站内容!:采集vue更多干货敬请关注/#/

推荐一个公众号【基于vue的前端团队合作】,开发的一个模块可以帮助你解决以下问题:如何利用vue获取web应用内部的自定义标签?如何利用vue获取web应用的根路径?如何利用vue获取web应用的组件路径?如何利用vue获取代码仓库/gitlab?如何利用vue获取web应用内部的根路径?如何使用rxjs自定义根路径?如何使用vue和vuex、flux、bootstrap等其他解决方案的集成?如何使用vue解决打包/打包分包/组件开发等问题?如何应用es6/vuex/es6exports等vuex特性?如何使用vue解决各种前端页面静态资源打包问题?vue的性能优化方案可以分为如下几个阶段:。

1)前端静态资源的拼接比如vue里面整个网页的静态资源使用一个ejs,ejs将静态资源分割为media-source-vue或者xml-source-vue文件(每个xml文件即是一个meta标签)。虽然vue在某些情况下不需要加载media-source-vue文件,但是如果后端apache写好页面内容后,需要再把静态资源(也就是media-source-vue)丢到前端页面去使用,这时候就需要用到vue的postcss特性或者由他人配置使用模板引擎生成静态资源。

2)vuex特性(重要)vuex的相关性能优化工作很多:vuex提供的store可以把后端apache中的静态资源拷贝到前端页面用作响应式页面,vuex中包含的component可以把后端apache中的静态资源拷贝到前端页面使用响应式的router对vue进行push/pull,或者通过vuex转换响应式路由。

3)vue-loader特性(重要)vue-loader打包vue中的exports,并且解决了vuex属性转换问题。

1)打包-高德es6-plugin

2)输出state-vue

3)component-vue在npm官网中,也有打包jsx或者modulexml等插件,

自动采集网站内容简单的说就是你想采集的

采集交流 • 优采云 发表了文章 • 0 个评论 • 149 次浏览 • 2021-08-14 01:01

自动采集网站内容简单的说就是你可以通过一款开源采集软件把你想采集的网站内容或者整站网站内容采集下来。

任何站点都有内容,都有版权。我的建议是,只要确定你的站点没有盗版,完全可以采用提供的自动化工具。如果你不知道用什么工具,请使用基于github的自动化采集,像grobotist或者forespider。不过,如果你使用该产品,记得第一次使用需要开发人员协助才能使用,付费后可在线使用。

有自动采集。

未来的采集方式:

1、版权侵权相关问题,目前实施比较困难,现在一些站点就存在版权侵权的问题,我不赞成盗版,从人人可以创造出知识产权的角度讲盗版对于促进某些行业的发展不利,

2、采集就是将你所想采集的网站内容列出,然后让采集工具自动整理采集下来,也就是外采;之前做技术时看过一篇文章分析欧美站点的用户体验怎么做、有些看得比较浅,

3、就我的了解国内也有一些专门做海外站的,

原来的站长需要精准的内容更新的才会被关注,所以最直接的就是自己翻译外部资源后,到自己的站点,目前主要是谷歌和baidu等搜索引擎。但是随着国内网站内容量的增多,引擎的抓取速度被降低。而想要优化外部内容,需要从自己的站点进行外部内容爬取。 查看全部

自动采集网站内容简单的说就是你想采集的

自动采集网站内容简单的说就是你可以通过一款开源采集软件把你想采集的网站内容或者整站网站内容采集下来。

任何站点都有内容,都有版权。我的建议是,只要确定你的站点没有盗版,完全可以采用提供的自动化工具。如果你不知道用什么工具,请使用基于github的自动化采集,像grobotist或者forespider。不过,如果你使用该产品,记得第一次使用需要开发人员协助才能使用,付费后可在线使用。

有自动采集。

未来的采集方式:

1、版权侵权相关问题,目前实施比较困难,现在一些站点就存在版权侵权的问题,我不赞成盗版,从人人可以创造出知识产权的角度讲盗版对于促进某些行业的发展不利,

2、采集就是将你所想采集的网站内容列出,然后让采集工具自动整理采集下来,也就是外采;之前做技术时看过一篇文章分析欧美站点的用户体验怎么做、有些看得比较浅,

3、就我的了解国内也有一些专门做海外站的,

原来的站长需要精准的内容更新的才会被关注,所以最直接的就是自己翻译外部资源后,到自己的站点,目前主要是谷歌和baidu等搜索引擎。但是随着国内网站内容量的增多,引擎的抓取速度被降低。而想要优化外部内容,需要从自己的站点进行外部内容爬取。

Google研发的数据采集插件,这款插件自带反爬虫能力

采集交流 • 优采云 发表了文章 • 0 个评论 • 376 次浏览 • 2021-08-13 19:06

指南:

【几乎每个人都需要从网上批量获取信息,比如批量邮件采集网站,批量的商家信息和采集1688、58所在城市的联系方式,如果让你学编程语言?

几乎每个人都有从网上批量获取信息的需求,比如批量邮件采集网站、批量采集1688、58 同城的商家信息和联系方式,如果你让你去学编程语言?我想很多人连软件都装不了,更别说一门完整的编程语言,还要学会正确的网络知识;学习优采云软件?一个很贵,另一个操作起来很麻烦。

今天推荐一个谷歌开发的数据采集插件。这个插件可以带有 cookie 和反爬虫功能。这是非常容易使用。按照流程,基本上10分钟就可以学会了。我一般用采集微博、知乎、豆瓣、58同城、大众点评、汽车之家等网站,很方便。

Web scraper 是 Google 强大的插件库中非常强大的数据采集 插件。它具有强大的反爬虫能力。只需在插件上进行设置,即可快速抓取知乎、简书、豆瓣、大众、58等大、中、小等网站90%以上的内容,包括文字、图片、表格和其他内容,最后快速导出csv格式文件。谷歌官方给出的网络爬虫描述是:

使用我们的扩展程序,您可以创建计划(站点地图)、应如何遍历网站以及应提取的内容。使用这些站点地图,网络爬虫将相应地导航站点并提取所有数据。您可以稍后将剪辑的数据导出为 CSV。

这个系列是关于网络爬虫的介绍。完整介绍流程,以知乎、简书等网站为例介绍如何采集文本、表格、多元素爬取、不规则分页爬取、副页爬取、动态网站爬虫,以及一些反爬虫技术等

好的,今天就来介绍一下网络爬虫的安装和完整的爬取过程。

一、web 爬虫安装

网络爬虫是谷歌浏览器的扩展插件,您只需在谷歌浏览器上安装即可。介绍两种安装方式:

1、打开google浏览器更多工具下的扩展程序-进入chrome web应用点-搜索web scraper-点击安装,如下图

但是上面的安装方法需要翻墙到网站国外,所以需要使用vpn,如果你有vpn可以用这种方法,如果没有可以用下面第二种方法:

2、 通过链接:密码:m672,下载网络爬虫安装程序。然后直接将安装程序拖入chrome中的扩展程序即可完成安装。

完成后即可使用。

二、以知乎为例介绍网络爬虫的完整爬取过程

1、Open target网站,这里以采集知乎第一大v张佳玮的follower为例,需要爬取的是知乎名字,回答数,文章关注@Quantity,关注数量。

2、在网页上右击,选择勾选选项,或者使用快捷键Ctrl+Shift+I/F12打开Web Scraper。

3、打开后,点击创建站点地图,选择创建站点地图,创建站点地图。

点击create sitemap后,会出现如图所示的页面。您需要填写站点地图名称,即站点的名称。你可以随便写,只要你能看懂;还需要填写start url,就是抓取页面的链接。填写完毕后,点击创建站点地图,完成站点地图的创建。

详情如下:

4、设置一级选择器:选择采集范围

接下来是重中之重。这里先介绍一下网络爬虫的爬取逻辑:需要设置一级选择器(selector),设置需要爬取的范围;在一级选择器下创建二级选择器(selector),并设置需要爬取Elements和content。

以抓张嘉伟的粉丝为例。我们的范围是张家伟关注的对象。然后我们需要为这个范围创建一个选择器;而张家卫关注对象的粉丝数、文章@number等内容都是二级选择器的内容。具体步骤如下:

(1)添加新选择器创建一级选择器选择器:

点击后可以得到如下页面,需要抓取的内容都设置在这个页面上。

id:就叫选择器,同理,只要你自己能理解,这里就叫jiawei-scrap。

Type:是要抓取的内容的类型,比如element element/text/link link/picture image/Element Scroll Down 动态加载等,这里如果有多个元素,选择element。

Selector:指选择要抓取的内容。单击选择以选择页面上的内容。下面详细介绍这部分。

Check Multiple:勾选 Multiple 前面的小框,因为要选择多个元素而不是单个元素。勾选后,爬虫插件会识别页面下具有相同属性的内容;

(2)这一步需要设置选中的内容,点击选择选项下的选择,得到如下图:

之后,将鼠标移动到需要选择的内容上,需要的内容会变成绿色表示被选中。这里需要提醒一下,如果你需要的内容是多元素的,你需要把元素都改为Select both。例如如下图,绿色表示选中的内容在绿色范围内。

选中内容范围后,点击鼠标,选中的内容范围会变成红色,如下图:

当一个内容变成红色时,我们可以选择下一秒的内容。点击后,网络爬虫会自动识别你想要的内容,元素相同的内容都会变成红色。如下图所示:

确认页面上我们需要的所有内容都变成红色后,点击完成选择选项,可以得到如下图:

点击保存选择器保存设置。在此之后,创建了第一级选择器。

5、设置二级选择器:选择需要采集的元素内容。

(1)点击下图中红框内容进入一级选择器jiawei-scrap:

(2)点击添加新选择器创建二级选择器来选择特定内容。

得到如下图,与一级选择器的内容相同,只是设置不同。

id:表示要获取的字段。您可以参加该领域的英语。比如要选择“作者”,就写“作者”;

Type:这里选择Text选项,因为你要抓取的是文本内容;

Multiple:Multiple 前面的小方框不要打勾,因为这里是要捕获的单个元素;

保留设置:其余未提及的保留默认设置。

(3)点击选择选项后,将鼠标移动到特定元素上,该元素会变成黄色,如下图:

点击特定元素后,该元素会变成红色,表示内容被选中。

(4)点击Done选择完成选择,然后点击保存选择器完成关注者知乎name的选择。

重复以上操作,直到选择好要攀爬的场地。

(5)点击红框可以看到采集的内容。

数据预览可以看到采集的内容,编辑可以修改设置内容。

6、爬取数据

(1)只需要设置好所有的selector,就可以开始爬取数据了,点击Scrape map,

选择刮取;:

(2)点击后会跳转到时间设置页面,如下图。由于采集数量不多,可以保存默认。点击开始抓取,会出现一个窗口弹出,官方采集Up。

(3)稍等片刻,得到采集效果,如下图:

(4)在sitemap下选择export data as csv选项,以表格的形式导出采集的结果。

文章1@

表格效果:

文章2@

以上是以知乎为例介绍采集的基本步骤和设置。虽然细节很多,但是仔细算算下来,真的没有多少步骤。基本上10分钟就可以完全掌握采集的流程;不管网站的类型,设置的基本过程大致相同,有兴趣的可以仔细研究一下。 查看全部

Google研发的数据采集插件,这款插件自带反爬虫能力

指南:

【几乎每个人都需要从网上批量获取信息,比如批量邮件采集网站,批量的商家信息和采集1688、58所在城市的联系方式,如果让你学编程语言?

几乎每个人都有从网上批量获取信息的需求,比如批量邮件采集网站、批量采集1688、58 同城的商家信息和联系方式,如果你让你去学编程语言?我想很多人连软件都装不了,更别说一门完整的编程语言,还要学会正确的网络知识;学习优采云软件?一个很贵,另一个操作起来很麻烦。

今天推荐一个谷歌开发的数据采集插件。这个插件可以带有 cookie 和反爬虫功能。这是非常容易使用。按照流程,基本上10分钟就可以学会了。我一般用采集微博、知乎、豆瓣、58同城、大众点评、汽车之家等网站,很方便。

Web scraper 是 Google 强大的插件库中非常强大的数据采集 插件。它具有强大的反爬虫能力。只需在插件上进行设置,即可快速抓取知乎、简书、豆瓣、大众、58等大、中、小等网站90%以上的内容,包括文字、图片、表格和其他内容,最后快速导出csv格式文件。谷歌官方给出的网络爬虫描述是:

使用我们的扩展程序,您可以创建计划(站点地图)、应如何遍历网站以及应提取的内容。使用这些站点地图,网络爬虫将相应地导航站点并提取所有数据。您可以稍后将剪辑的数据导出为 CSV。

这个系列是关于网络爬虫的介绍。完整介绍流程,以知乎、简书等网站为例介绍如何采集文本、表格、多元素爬取、不规则分页爬取、副页爬取、动态网站爬虫,以及一些反爬虫技术等

好的,今天就来介绍一下网络爬虫的安装和完整的爬取过程。

一、web 爬虫安装

网络爬虫是谷歌浏览器的扩展插件,您只需在谷歌浏览器上安装即可。介绍两种安装方式:

1、打开google浏览器更多工具下的扩展程序-进入chrome web应用点-搜索web scraper-点击安装,如下图

但是上面的安装方法需要翻墙到网站国外,所以需要使用vpn,如果你有vpn可以用这种方法,如果没有可以用下面第二种方法:

2、 通过链接:密码:m672,下载网络爬虫安装程序。然后直接将安装程序拖入chrome中的扩展程序即可完成安装。

完成后即可使用。

二、以知乎为例介绍网络爬虫的完整爬取过程

1、Open target网站,这里以采集知乎第一大v张佳玮的follower为例,需要爬取的是知乎名字,回答数,文章关注@Quantity,关注数量。

2、在网页上右击,选择勾选选项,或者使用快捷键Ctrl+Shift+I/F12打开Web Scraper。

3、打开后,点击创建站点地图,选择创建站点地图,创建站点地图。

点击create sitemap后,会出现如图所示的页面。您需要填写站点地图名称,即站点的名称。你可以随便写,只要你能看懂;还需要填写start url,就是抓取页面的链接。填写完毕后,点击创建站点地图,完成站点地图的创建。

详情如下:

4、设置一级选择器:选择采集范围

接下来是重中之重。这里先介绍一下网络爬虫的爬取逻辑:需要设置一级选择器(selector),设置需要爬取的范围;在一级选择器下创建二级选择器(selector),并设置需要爬取Elements和content。

以抓张嘉伟的粉丝为例。我们的范围是张家伟关注的对象。然后我们需要为这个范围创建一个选择器;而张家卫关注对象的粉丝数、文章@number等内容都是二级选择器的内容。具体步骤如下:

(1)添加新选择器创建一级选择器选择器:

点击后可以得到如下页面,需要抓取的内容都设置在这个页面上。

id:就叫选择器,同理,只要你自己能理解,这里就叫jiawei-scrap。

Type:是要抓取的内容的类型,比如element element/text/link link/picture image/Element Scroll Down 动态加载等,这里如果有多个元素,选择element。

Selector:指选择要抓取的内容。单击选择以选择页面上的内容。下面详细介绍这部分。

Check Multiple:勾选 Multiple 前面的小框,因为要选择多个元素而不是单个元素。勾选后,爬虫插件会识别页面下具有相同属性的内容;

(2)这一步需要设置选中的内容,点击选择选项下的选择,得到如下图:

之后,将鼠标移动到需要选择的内容上,需要的内容会变成绿色表示被选中。这里需要提醒一下,如果你需要的内容是多元素的,你需要把元素都改为Select both。例如如下图,绿色表示选中的内容在绿色范围内。

选中内容范围后,点击鼠标,选中的内容范围会变成红色,如下图:

当一个内容变成红色时,我们可以选择下一秒的内容。点击后,网络爬虫会自动识别你想要的内容,元素相同的内容都会变成红色。如下图所示:

确认页面上我们需要的所有内容都变成红色后,点击完成选择选项,可以得到如下图:

点击保存选择器保存设置。在此之后,创建了第一级选择器。

5、设置二级选择器:选择需要采集的元素内容。

(1)点击下图中红框内容进入一级选择器jiawei-scrap:

(2)点击添加新选择器创建二级选择器来选择特定内容。

得到如下图,与一级选择器的内容相同,只是设置不同。

id:表示要获取的字段。您可以参加该领域的英语。比如要选择“作者”,就写“作者”;

Type:这里选择Text选项,因为你要抓取的是文本内容;

Multiple:Multiple 前面的小方框不要打勾,因为这里是要捕获的单个元素;

保留设置:其余未提及的保留默认设置。

(3)点击选择选项后,将鼠标移动到特定元素上,该元素会变成黄色,如下图:

点击特定元素后,该元素会变成红色,表示内容被选中。

(4)点击Done选择完成选择,然后点击保存选择器完成关注者知乎name的选择。

重复以上操作,直到选择好要攀爬的场地。

(5)点击红框可以看到采集的内容。

数据预览可以看到采集的内容,编辑可以修改设置内容。

6、爬取数据

(1)只需要设置好所有的selector,就可以开始爬取数据了,点击Scrape map,

选择刮取;:

(2)点击后会跳转到时间设置页面,如下图。由于采集数量不多,可以保存默认。点击开始抓取,会出现一个窗口弹出,官方采集Up。

(3)稍等片刻,得到采集效果,如下图:

(4)在sitemap下选择export data as csv选项,以表格的形式导出采集的结果。

文章1@

表格效果:

文章2@

以上是以知乎为例介绍采集的基本步骤和设置。虽然细节很多,但是仔细算算下来,真的没有多少步骤。基本上10分钟就可以完全掌握采集的流程;不管网站的类型,设置的基本过程大致相同,有兴趣的可以仔细研究一下。

本文最初发布1.3版本免授权,全开源,不加密

采集交流 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-08-13 05:07

本文最初发表于 2020 年 8 月 4 日下午 10:05

WordPress大门户主题1.3自动采集门户新闻新闻媒体网站template源码

主题为1.3新版,免授权,完全开源,不加密。

<p>采集Rules 1年内包更新失效(有人低价买模板转卖,规则不收录更新。不要贪便宜,影响网站的运行) 查看全部

本文最初发布1.3版本免授权,全开源,不加密

本文最初发表于 2020 年 8 月 4 日下午 10:05

WordPress大门户主题1.3自动采集门户新闻新闻媒体网站template源码

主题为1.3新版,免授权,完全开源,不加密。

<p>采集Rules 1年内包更新失效(有人低价买模板转卖,规则不收录更新。不要贪便宜,影响网站的运行)

自动采集网站内容是分文本采集和网页链接采集的

采集交流 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2021-08-08 11:00

自动采集网站内容是分文本采集和网页链接采集,又因为不同网站内容丰富程度不同,需要采集的内容也不同,可以从两个方面入手。文本采集是专门采集网站搜索框内容,常见的网站有百度新闻,360搜索,搜狗搜索,搜搜百科等等,这些网站的内容和站内搜索框共享相同的robots.txt即协议。这些采集包含的内容其实是标准的,即目标网站相关链接和网站结构信息等内容,可以采集得到。

而网页链接采集是针对网站内容有一定自己的内容库,又因为网站的文章密度不断提高,想更新新的文章,就需要整理修订网站网页并转发给别人,这时可以在网站上采集相关文章,再转发给需要的人去浏览和发布。举个例子,要发布一篇名为xxx的文章,你在网站上发布后内容不就可以有:标题,作者,主要内容,发布时间,文章链接等内容了吗?采集方式可以分为两类,一类是爬虫,另一类是页面(archive)采集。

爬虫类采集,是采集指定网站的搜索结果页网页结构,再对其进行跟新处理,同时采集网站内部的新文章。采集方式的目的是将整个网站的内容进行梳理与归类。这种方式有一定难度,用好了还是不错的。但爬虫采集难度比较大,一不小心就容易走入陷阱。页面采集,是将页面链接采集下来,然后将同样的页面文章按照id进行对应,一般要搜索页面id的关键词。

页面采集可以采集到对应页面内的更新相关的内容,能够保持搜索的更新速度。根据网站实际情况来决定采用哪种采集方式。 查看全部

自动采集网站内容是分文本采集和网页链接采集的

自动采集网站内容是分文本采集和网页链接采集,又因为不同网站内容丰富程度不同,需要采集的内容也不同,可以从两个方面入手。文本采集是专门采集网站搜索框内容,常见的网站有百度新闻,360搜索,搜狗搜索,搜搜百科等等,这些网站的内容和站内搜索框共享相同的robots.txt即协议。这些采集包含的内容其实是标准的,即目标网站相关链接和网站结构信息等内容,可以采集得到。

而网页链接采集是针对网站内容有一定自己的内容库,又因为网站的文章密度不断提高,想更新新的文章,就需要整理修订网站网页并转发给别人,这时可以在网站上采集相关文章,再转发给需要的人去浏览和发布。举个例子,要发布一篇名为xxx的文章,你在网站上发布后内容不就可以有:标题,作者,主要内容,发布时间,文章链接等内容了吗?采集方式可以分为两类,一类是爬虫,另一类是页面(archive)采集。

爬虫类采集,是采集指定网站的搜索结果页网页结构,再对其进行跟新处理,同时采集网站内部的新文章。采集方式的目的是将整个网站的内容进行梳理与归类。这种方式有一定难度,用好了还是不错的。但爬虫采集难度比较大,一不小心就容易走入陷阱。页面采集,是将页面链接采集下来,然后将同样的页面文章按照id进行对应,一般要搜索页面id的关键词。

页面采集可以采集到对应页面内的更新相关的内容,能够保持搜索的更新速度。根据网站实际情况来决定采用哪种采集方式。

就是大牛老7分享个人网站利用python配合C++全自动采集内容站群算法

采集交流 • 优采云 发表了文章 • 0 个评论 • 417 次浏览 • 2021-08-07 06:22

国庆节将至,所有站长论坛干货和征文活动都开始了。这里是loc Daniel 7 分享我个人的网站 using python with C++全自动采集内容站群法做adsense月度入门万道实用程序。虽然不是教程方法,但是老7通过回答大家的问题,让基础用户得到了一些想法。毕竟很多事情都不能说的太清楚,如果没有依据,再多说也没有用。每个人都有自己的网络营销方式。

这个算法是python和C++。经过两个月的人工智能提升和训练,增收效果明显。当然,最重要的是新算法有效。在下面的4张图中,7月份为9,000多美元,8月份略有增加,本月为13,000美元。这只是老7网站收入的一部分,google adsense的收入超过了这个。另外需要分享的一点是,对于年收入超过5万美元且受外汇管制的paypal,用户可以直接致电上海办事处,客服会告诉你一些提高限额的渠道。下图是paypal收了200,感觉美元手续费有点高。

思路和有些人说的全自动采集内容做站群类似,用自己的算法混淆谷歌的思路比较接近,但是摸索了很多具体细节还是有点效果的,主要是依靠大数据和机器深度学习。而且工作也没有很多人想象的那么容易,采集会根据源码做相应的调整。此外,目前对百度的影响仍然有限。很多关键词搜索结果在百度中不匹配。不是百度不懂,而是百度自私。 Google 会在第一时间向用户呈现最正确的用户所需的结果。

老 7 也在独自工作。过去,一个5人的小团队,因为长大后结婚生子,各自去上班。他们还利用github上开源的人工智能和深度学习组件搭建了一个机器群,实际上只是几台功能强大的机器。服务器。按照AlphaGo的思路,让它在网上自己学习和计算,在一些(你知道的)搜索引擎和网站上给出最好的方法和比较方法,可以取得优势。比如站群端,自己列出单价和浏览量,然后自己采集数据,创建对应的网站(这个是python实现的)。这样做的好处是不会被谷歌或其他反作弊系统识别,可以长期稳定完成。

对于一些人对全自动采集站可读性的质疑,老7说他试图把最有效的方法之一解释清楚。 ”比如有一段时间,《风油精》关键词很火——全智能大数据分析,你也可以搭建这样一个大数据分析链,也可以用一些机构的成果,还有,我就直接把结果提取出来了,之后用这个关键词快速创建了域名和与之相关的网站(这个可以程序员实现,我用python,赞python),整个过程接近关键词的病毒扫描和创建,以web形式呈现,流量非常可怕,所以我有很多小vps负责负载。这是谷歌的一个方面,一些细节属于个人既然掌握了核心技术,到了那里就可以真正理解了。”

“稍微说一下,关键是结局。仔细想想,你就会明白,机会是给有准备的人的。比如关键词“风油精”,不管是不是网站围绕这个词无论是论坛版块,还是单页文章,所有的信息和数据都是智能的采集网络(有开源程序来判断文本的流畅性和可读性,不要担心这个),然后把采集的数据怎么排列@是亮点,模拟回复的方式,紧凑的,懂吗?用户认为人在回复,比如用这个风油精的体验,PV会爆,我的小vps受不了怎么办?Github页面,无限制,小vps+github不用担心任何问题。关于检测句子的流畅度和可读性,我把它从我的程序里去掉 是的,太影响速度和效率了。我还以为我会去其他平台com逐句删减。干脆把它去掉,反正采集到的信息基本是流畅完整的,然后就可以通过某种方式(算法)打乱拼接了。只需努力实现非常低的网络重复率即可。”

关于adsense垃圾采集站为K账号的问题,老7分享:“首先,不要说站垃圾不是垃圾,包括谷歌在内的任何公司都不会定义网站是不是垃圾或者歧视采集来文章不会被认为是劣等的,比如很多人复制shadowsocks文章,*现在百度已经屏蔽了shadowsocks关键词*,文章的一些技巧和知识适合他们。你只是让它存在于你的小网站上,这是有道理的。搜索引擎关注转化率和价值(复制的文章也有价值,高低,原创价值最高)。你是k 一些不当流量,不要买所谓的几万ip流量,我告诉你,最好不要买(冒犯了某些人的利益,抱歉)原理和原因就不解释了,码字很烦,很反感。二是莫名的点击和跳转后的停留时间等因素。我有很多g账号,还有过去两年我没有K。可以借鉴,最后祝大家网赚快乐。”

相关链接:内容网站LOC大神小马一天在adsense上赚了一万美元。行业资讯网站优化高单价

访客,本帖隐藏内容需要点数大于5才能浏览,您当前点数为0 查看全部

就是大牛老7分享个人网站利用python配合C++全自动采集内容站群算法

国庆节将至,所有站长论坛干货和征文活动都开始了。这里是loc Daniel 7 分享我个人的网站 using python with C++全自动采集内容站群法做adsense月度入门万道实用程序。虽然不是教程方法,但是老7通过回答大家的问题,让基础用户得到了一些想法。毕竟很多事情都不能说的太清楚,如果没有依据,再多说也没有用。每个人都有自己的网络营销方式。

这个算法是python和C++。经过两个月的人工智能提升和训练,增收效果明显。当然,最重要的是新算法有效。在下面的4张图中,7月份为9,000多美元,8月份略有增加,本月为13,000美元。这只是老7网站收入的一部分,google adsense的收入超过了这个。另外需要分享的一点是,对于年收入超过5万美元且受外汇管制的paypal,用户可以直接致电上海办事处,客服会告诉你一些提高限额的渠道。下图是paypal收了200,感觉美元手续费有点高。

思路和有些人说的全自动采集内容做站群类似,用自己的算法混淆谷歌的思路比较接近,但是摸索了很多具体细节还是有点效果的,主要是依靠大数据和机器深度学习。而且工作也没有很多人想象的那么容易,采集会根据源码做相应的调整。此外,目前对百度的影响仍然有限。很多关键词搜索结果在百度中不匹配。不是百度不懂,而是百度自私。 Google 会在第一时间向用户呈现最正确的用户所需的结果。

老 7 也在独自工作。过去,一个5人的小团队,因为长大后结婚生子,各自去上班。他们还利用github上开源的人工智能和深度学习组件搭建了一个机器群,实际上只是几台功能强大的机器。服务器。按照AlphaGo的思路,让它在网上自己学习和计算,在一些(你知道的)搜索引擎和网站上给出最好的方法和比较方法,可以取得优势。比如站群端,自己列出单价和浏览量,然后自己采集数据,创建对应的网站(这个是python实现的)。这样做的好处是不会被谷歌或其他反作弊系统识别,可以长期稳定完成。

对于一些人对全自动采集站可读性的质疑,老7说他试图把最有效的方法之一解释清楚。 ”比如有一段时间,《风油精》关键词很火——全智能大数据分析,你也可以搭建这样一个大数据分析链,也可以用一些机构的成果,还有,我就直接把结果提取出来了,之后用这个关键词快速创建了域名和与之相关的网站(这个可以程序员实现,我用python,赞python),整个过程接近关键词的病毒扫描和创建,以web形式呈现,流量非常可怕,所以我有很多小vps负责负载。这是谷歌的一个方面,一些细节属于个人既然掌握了核心技术,到了那里就可以真正理解了。”

“稍微说一下,关键是结局。仔细想想,你就会明白,机会是给有准备的人的。比如关键词“风油精”,不管是不是网站围绕这个词无论是论坛版块,还是单页文章,所有的信息和数据都是智能的采集网络(有开源程序来判断文本的流畅性和可读性,不要担心这个),然后把采集的数据怎么排列@是亮点,模拟回复的方式,紧凑的,懂吗?用户认为人在回复,比如用这个风油精的体验,PV会爆,我的小vps受不了怎么办?Github页面,无限制,小vps+github不用担心任何问题。关于检测句子的流畅度和可读性,我把它从我的程序里去掉 是的,太影响速度和效率了。我还以为我会去其他平台com逐句删减。干脆把它去掉,反正采集到的信息基本是流畅完整的,然后就可以通过某种方式(算法)打乱拼接了。只需努力实现非常低的网络重复率即可。”

关于adsense垃圾采集站为K账号的问题,老7分享:“首先,不要说站垃圾不是垃圾,包括谷歌在内的任何公司都不会定义网站是不是垃圾或者歧视采集来文章不会被认为是劣等的,比如很多人复制shadowsocks文章,*现在百度已经屏蔽了shadowsocks关键词*,文章的一些技巧和知识适合他们。你只是让它存在于你的小网站上,这是有道理的。搜索引擎关注转化率和价值(复制的文章也有价值,高低,原创价值最高)。你是k 一些不当流量,不要买所谓的几万ip流量,我告诉你,最好不要买(冒犯了某些人的利益,抱歉)原理和原因就不解释了,码字很烦,很反感。二是莫名的点击和跳转后的停留时间等因素。我有很多g账号,还有过去两年我没有K。可以借鉴,最后祝大家网赚快乐。”

相关链接:内容网站LOC大神小马一天在adsense上赚了一万美元。行业资讯网站优化高单价

访客,本帖隐藏内容需要点数大于5才能浏览,您当前点数为0

自动采集网站内容和频道内容并没有发生变化?

采集交流 • 优采云 发表了文章 • 0 个评论 • 146 次浏览 • 2021-08-03 06:11

自动采集网站内容和频道内容,都是自动填充公共链接,但是,当你点击“阅读全文”链接时,你是否觉得网站内容和频道内容并没有发生变化?实际上,当你点击“阅读全文”时,自动填充了一个公共链接,当你浏览此链接时,它会自动和一个新内容提供者做匹配,这个内容提供者,一般称为:第三方机构、作者或个人。你浏览过的所有网站、频道,基本上都已经和该机构、作者做了匹配。

最后,当你点击“阅读全文”时,你获得的内容其实一样,不要认为存在什么“变化”,虽然这些变化并没有让网站内容本身变化,但这种变化会加快网站内容质量的下降。

是的,主要是内容的抓取时机不对,

因为ajax技术的存在,所以是通过网页显示来获取数据的,有过这段ajax过程,也就意味着网页也有那段数据抓取过程。

是的,目前一些视频网站是可以做到的,比如我们先看一些比较著名的网站,比如优酷,一些非一流的国内视频网站,类似爱奇艺搜狐,他们对外接口都是通过ajax从他们自己官方网站获取内容,然后插入广告下载等,你可以尝试改成代码,让他通过浏览器的时候获取你的视频,前提是得保证ua可以到网站去。

这里有一篇外文的介绍你可以看看-enable-feed-forecasting.html,建议看一下以及使用一定的技术。 查看全部

自动采集网站内容和频道内容并没有发生变化?

自动采集网站内容和频道内容,都是自动填充公共链接,但是,当你点击“阅读全文”链接时,你是否觉得网站内容和频道内容并没有发生变化?实际上,当你点击“阅读全文”时,自动填充了一个公共链接,当你浏览此链接时,它会自动和一个新内容提供者做匹配,这个内容提供者,一般称为:第三方机构、作者或个人。你浏览过的所有网站、频道,基本上都已经和该机构、作者做了匹配。

最后,当你点击“阅读全文”时,你获得的内容其实一样,不要认为存在什么“变化”,虽然这些变化并没有让网站内容本身变化,但这种变化会加快网站内容质量的下降。

是的,主要是内容的抓取时机不对,

因为ajax技术的存在,所以是通过网页显示来获取数据的,有过这段ajax过程,也就意味着网页也有那段数据抓取过程。

是的,目前一些视频网站是可以做到的,比如我们先看一些比较著名的网站,比如优酷,一些非一流的国内视频网站,类似爱奇艺搜狐,他们对外接口都是通过ajax从他们自己官方网站获取内容,然后插入广告下载等,你可以尝试改成代码,让他通过浏览器的时候获取你的视频,前提是得保证ua可以到网站去。

这里有一篇外文的介绍你可以看看-enable-feed-forecasting.html,建议看一下以及使用一定的技术。

教程教你基本玩转自动采集网站内容-乐题库

采集交流 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2021-08-03 03:11

自动采集网站内容,快速提高运营效率,提升用户粘性,就用自动采集器。本教程教你基本玩转自动采集网站内容。

一、案例介绍excel中列表格并不适合自动采集页面内容,所以首先上行表格形式一个网站,

一、准备工作

1、下载安装合适版本的采集工具,每款采集工具差异不大,我使用优采云采集器。

2、利用优采云采集器同时采集最多两个网站,可以采集4-5个网站。

二、步骤一:采集平台的设置

1、ctrl+enter批量搜索url,

2、然后在列表页结束打开公共搜索框。

3、按一下ctrl+c再按一下ctrl+v。当出现未响应时,输入则为采集网站输入1,2,3分别代表平台和网站列表页地址分别代表url列表页地址不变,因为一个页面只采集一个url网站地址改变,则url改变注意事项:url的格式是"baidu"、"tags"、".."一个url只能采集一个网站,比如输入""将只能采集""网站的内容所以需要每次更换采集平台。注意事项:http协议和https协议有区别,需要添加证书来确保安全性。

三、步骤二:统计自己采集网站数量

1、然后输入一个自己能找到的网站列表页地址。

2、然后点击采集计划,选择一个表格。

3、点击下一步。

4、选择一个数据量比较大的表格,点击下一步。

5、点击下一步。注意事项:每个网站自动采集数量有限,一个采集平台采集网站可能会超过100个,在数量达到一定规模后可以通过分布式架构来解决网站间数据同步问题。

四、步骤三:数据统计

1、右键复制链接地址,然后去找到该链接,右键打开网站地址列表页地址,替换该链接里的内容,复制地址并粘贴到搜索框即可。

2、使用快捷键ctrl+h打开查找对话框,在左侧列表框中选择【在列表中搜索】,右键粘贴内容。在右侧替换框中将内容重命名为该网站列表页地址,点击搜索,即可实现自动统计网站数量。

3、再次右键粘贴内容,替换为列表页地址即可。

4、需要使用快捷键ctrl+r查找到该页面,然后使用其中文字符“&”,粘贴网址,替换为-1&amp;next=1就实现采集该页面的内容。不用加引号粘贴。

5、最后右键浏览器菜单打开网址列表页地址窗口,替换为整个网站地址即可。从此告别baidu列表页内容搜索烦恼。自动采集网站内容,快速提高运营效率,提升用户粘性,就用自动采集器。 查看全部

教程教你基本玩转自动采集网站内容-乐题库

自动采集网站内容,快速提高运营效率,提升用户粘性,就用自动采集器。本教程教你基本玩转自动采集网站内容。

一、案例介绍excel中列表格并不适合自动采集页面内容,所以首先上行表格形式一个网站,

一、准备工作

1、下载安装合适版本的采集工具,每款采集工具差异不大,我使用优采云采集器。

2、利用优采云采集器同时采集最多两个网站,可以采集4-5个网站。

二、步骤一:采集平台的设置

1、ctrl+enter批量搜索url,

2、然后在列表页结束打开公共搜索框。

3、按一下ctrl+c再按一下ctrl+v。当出现未响应时,输入则为采集网站输入1,2,3分别代表平台和网站列表页地址分别代表url列表页地址不变,因为一个页面只采集一个url网站地址改变,则url改变注意事项:url的格式是"baidu"、"tags"、".."一个url只能采集一个网站,比如输入""将只能采集""网站的内容所以需要每次更换采集平台。注意事项:http协议和https协议有区别,需要添加证书来确保安全性。

三、步骤二:统计自己采集网站数量

1、然后输入一个自己能找到的网站列表页地址。

2、然后点击采集计划,选择一个表格。

3、点击下一步。

4、选择一个数据量比较大的表格,点击下一步。

5、点击下一步。注意事项:每个网站自动采集数量有限,一个采集平台采集网站可能会超过100个,在数量达到一定规模后可以通过分布式架构来解决网站间数据同步问题。

四、步骤三:数据统计

1、右键复制链接地址,然后去找到该链接,右键打开网站地址列表页地址,替换该链接里的内容,复制地址并粘贴到搜索框即可。

2、使用快捷键ctrl+h打开查找对话框,在左侧列表框中选择【在列表中搜索】,右键粘贴内容。在右侧替换框中将内容重命名为该网站列表页地址,点击搜索,即可实现自动统计网站数量。

3、再次右键粘贴内容,替换为列表页地址即可。

4、需要使用快捷键ctrl+r查找到该页面,然后使用其中文字符“&”,粘贴网址,替换为-1&amp;next=1就实现采集该页面的内容。不用加引号粘贴。

5、最后右键浏览器菜单打开网址列表页地址窗口,替换为整个网站地址即可。从此告别baidu列表页内容搜索烦恼。自动采集网站内容,快速提高运营效率,提升用户粘性,就用自动采集器。

自动采集网站内容(#全网网址采集器全网可用在哪里运行本采集器可用运行 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-09-03 23:04

)

整个网站采集器(cobweb)

这是一个golang写的网站采集器,可以自动抓取所有可以到达的网站信息。 URL采集器会自动采集并分析网站的标题、站点描述、微信、QQ、联系方式、网站使用的运行环境、ip信息等,甚至分析使用的框架网站。

全新升级,使用sqlite作为数据库,不再需要安装mysql,直接运行可执行文件即可抓取内容。

为什么全网URL采集器全网URL采集器能采集什么内容

这个采集器can采集的内容是:文章title、文章关键词、文章description、文章detailed content、文章author、文章release time、 文章views。

##全网网站采集器可以运行的地方采集器可以运行在Windows系统、Mac系统、Linux系统(Centos、Ubuntu等),可以下载编译好的程序直接执行,或者你可以下载源代码自己编译。

如何安装和使用

go env -w GOPROXY=https://goproxy.cn,direct

最后执行如下命令

go mod tidy

go mod vendor

go build app/main.go

## 跨平台编译Windows版本

CGO_ENABLED=1 CC=x86_64-w64-mingw32-gcc CXX=x86_64-w64-mingw32-g++ GOOS=windows GOARCH=amd64 go build -x -v -ldflags "-s -w" -o cobweb.exe ./app/main.go 查看全部

自动采集网站内容(#全网网址采集器全网可用在哪里运行本采集器可用运行

)

整个网站采集器(cobweb)

这是一个golang写的网站采集器,可以自动抓取所有可以到达的网站信息。 URL采集器会自动采集并分析网站的标题、站点描述、微信、QQ、联系方式、网站使用的运行环境、ip信息等,甚至分析使用的框架网站。

全新升级,使用sqlite作为数据库,不再需要安装mysql,直接运行可执行文件即可抓取内容。

为什么全网URL采集器全网URL采集器能采集什么内容

这个采集器can采集的内容是:文章title、文章关键词、文章description、文章detailed content、文章author、文章release time、 文章views。

##全网网站采集器可以运行的地方采集器可以运行在Windows系统、Mac系统、Linux系统(Centos、Ubuntu等),可以下载编译好的程序直接执行,或者你可以下载源代码自己编译。

如何安装和使用

go env -w GOPROXY=https://goproxy.cn,direct

最后执行如下命令

go mod tidy

go mod vendor

go build app/main.go

## 跨平台编译Windows版本

CGO_ENABLED=1 CC=x86_64-w64-mingw32-gcc CXX=x86_64-w64-mingw32-g++ GOOS=windows GOARCH=amd64 go build -x -v -ldflags "-s -w" -o cobweb.exe ./app/main.go

自动采集网站内容(马克斯4.0内核的2013最新奇热电影网源码,极具商业价值源码)

采集交流 • 优采云 发表了文章 • 0 个评论 • 188 次浏览 • 2021-09-03 22:24

Max4.0内核2013最新奇热电影网全站源码,一组极具商业价值的源码,网上随处可见小贩。这里发布的奇瑞影业全站源码完全可用且完整,全站生成静态页面

背景路径您的网址/管理员

管理账号和密码分别是admin

源码架构:ASP+ACCESS(mssql)(源码附详细安装说明)

源码说明:新增功能全自动采集+无人值守,加入迅雷下载电影,mp3 mp4,3万余条原创资料,主栏目,影视剧,电影动漫,综艺,微电影,留言看板、电影排行、口水、电视直播,页面可以显示asp+acc或者选择mssql。全站可以选择动态、伪静态、全静态的群站主,有福了!

特殊功能:

1、简洁却不大气的界面让用户流连忘返。

2、新颖的历史浏览记录,在不影响界面美观的同时,也增加了用户的停留时间。

3、电影电视剧独有的幻灯片完全自动调用,免去手动更新幻灯片的麻烦。

4、支持迅雷下载,在线观看和离线下载都正确。

5、调整栏目页面,以字母形式显示,更类似于Qi Hot。

6、一键采集,每天更新内容方便搜索引擎抓取。

7、触发自动采集,只要有流量,就可以实现采集自动更新。

8、逆序添加播放列表,让最新一集不会沉底!

9、首页增加公告提醒。直接后台管理更方便。

10、新增口水排行榜,将评论替换为大纲,防止垃圾评论过多影响网站的专业性。

11、 简洁专题名人专页,想看哪部名人电影,想看就点多看。

下载链接:

下载地址 查看全部

自动采集网站内容(马克斯4.0内核的2013最新奇热电影网源码,极具商业价值源码)

Max4.0内核2013最新奇热电影网全站源码,一组极具商业价值的源码,网上随处可见小贩。这里发布的奇瑞影业全站源码完全可用且完整,全站生成静态页面

背景路径您的网址/管理员

管理账号和密码分别是admin

源码架构:ASP+ACCESS(mssql)(源码附详细安装说明)

源码说明:新增功能全自动采集+无人值守,加入迅雷下载电影,mp3 mp4,3万余条原创资料,主栏目,影视剧,电影动漫,综艺,微电影,留言看板、电影排行、口水、电视直播,页面可以显示asp+acc或者选择mssql。全站可以选择动态、伪静态、全静态的群站主,有福了!

特殊功能:

1、简洁却不大气的界面让用户流连忘返。

2、新颖的历史浏览记录,在不影响界面美观的同时,也增加了用户的停留时间。

3、电影电视剧独有的幻灯片完全自动调用,免去手动更新幻灯片的麻烦。

4、支持迅雷下载,在线观看和离线下载都正确。

5、调整栏目页面,以字母形式显示,更类似于Qi Hot。

6、一键采集,每天更新内容方便搜索引擎抓取。

7、触发自动采集,只要有流量,就可以实现采集自动更新。

8、逆序添加播放列表,让最新一集不会沉底!

9、首页增加公告提醒。直接后台管理更方便。

10、新增口水排行榜,将评论替换为大纲,防止垃圾评论过多影响网站的专业性。

11、 简洁专题名人专页,想看哪部名人电影,想看就点多看。

下载链接:

下载地址

自动采集网站内容(自动采集网站内容是大部分站长进行优化时最常用的方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 175 次浏览 • 2021-09-02 02:05

自动采集网站内容是大部分站长进行优化时最常用的方法,

1、博客发布

2、论坛发布

3、中文网站发布内容

4、谷歌发布

5、b2b发布/b2b/

6、百度知道

7、问答网站

8、百度百科

9、龙空1

0、58发布1

1、百度百科1

2、百度知道1

3、百度贴吧1

4、谷歌快照-最大全球站长社区

1、全站高清的图片加快了网站页面的打开速度,

2、对网站页面按照类型进行分类,让搜索引擎能够根据不同的内容进行不同的分类,

3、对站内标题栏和对应的网页锚文本进行字体颜色的改变,提高网站在百度中的抓取效果,改变搜索引擎对网站页面的排序,

4、添加关键词导航、一级页面、二级页面等高质量的网页内容,

5、增加html文本内容,让用户轻松输入引起,进行内容的搜索。

6、不要只做网站的主页,可以同时做几个页面,这样可以让搜索引擎对网站页面做到更深层次的检索,

7、对于那些短小精悍的页面,可以添加图片,增加页面的丰富度。

8、同类型的网站页面一般都会通过同样的方式进行网站页面的搜索,让搜索引擎对该站有一个良好的体验,形成一个良性循环。不过还是有很多站长对此没有采取。另外还有一个隐藏技能:8.2浏览器内核。高速ms内核显示9.3杀毒软件或防火墙可能是网站被搜索引擎判断为竞争对手的关键。它们对网站内部的内容进行对比然后进行行为的惩罚甚至降权。

因此搜索引擎可能会在你浏览其他网站或搜索引擎链接时给你带来不良反应。因此,防止这些危险因素发生你的网站就变得尤为重要。 查看全部

自动采集网站内容(自动采集网站内容是大部分站长进行优化时最常用的方法)

自动采集网站内容是大部分站长进行优化时最常用的方法,

1、博客发布

2、论坛发布

3、中文网站发布内容

4、谷歌发布

5、b2b发布/b2b/

6、百度知道

7、问答网站

8、百度百科

9、龙空1

0、58发布1

1、百度百科1

2、百度知道1

3、百度贴吧1

4、谷歌快照-最大全球站长社区

1、全站高清的图片加快了网站页面的打开速度,

2、对网站页面按照类型进行分类,让搜索引擎能够根据不同的内容进行不同的分类,

3、对站内标题栏和对应的网页锚文本进行字体颜色的改变,提高网站在百度中的抓取效果,改变搜索引擎对网站页面的排序,

4、添加关键词导航、一级页面、二级页面等高质量的网页内容,

5、增加html文本内容,让用户轻松输入引起,进行内容的搜索。

6、不要只做网站的主页,可以同时做几个页面,这样可以让搜索引擎对网站页面做到更深层次的检索,

7、对于那些短小精悍的页面,可以添加图片,增加页面的丰富度。

8、同类型的网站页面一般都会通过同样的方式进行网站页面的搜索,让搜索引擎对该站有一个良好的体验,形成一个良性循环。不过还是有很多站长对此没有采取。另外还有一个隐藏技能:8.2浏览器内核。高速ms内核显示9.3杀毒软件或防火墙可能是网站被搜索引擎判断为竞争对手的关键。它们对网站内部的内容进行对比然后进行行为的惩罚甚至降权。

因此搜索引擎可能会在你浏览其他网站或搜索引擎链接时给你带来不良反应。因此,防止这些危险因素发生你的网站就变得尤为重要。

自动采集网站内容(海洋cms怎么设置宝塔自动采集:获取脚本代码。)

采集交流 • 优采云 发表了文章 • 0 个评论 • 216 次浏览 • 2021-09-01 07:23

Oceancms如何设置宝塔自动采集,因为很多人都在问这个问题,所以有这个教程。虽然oceancms给出了脚本代码,但是对于刚接触oceancms的用户来说,理解并不是那么容易。今天就详细介绍一下使用海洋cms自动采集的具体步骤。

Oceancms如何设置宝塔自动采集第一步:获取脚本代码。

[1] 以下是Oceancms官网提供的自动采集脚本代码。我们需要修改代码中的3项才可以使用。

#!/bin/bash

########################################################

# 程序名称: 海洋CMS自动采集脚本

# 版本信息:seacmsbot/ v2.0

# 发布链接: https://www.seacms.net/post-update-92579.htm

# 使用方法:直接复制代码到宝塔计划任务shell脚本内容里添加每小时任务使用

# 更新时间:2019.9.26

##########################################################

# ①请修改下面的网站域名及管理目录

web_site = "http://网站域名/管理目录/admin_reslib2.php"

# ②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd = "8888e82e85bd4540f0defa3fb7a8e888"

# ③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

# 每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api = (

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

# 模拟用户浏览器ua,请勿随意修改,以免被目标防火墙拦截!

web_ua = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko)

Chrome / 76.0

.3809

.100

Safari / 537.36

seacmsbot / 1.2;

"

# 采集单页

function

get_content()

{

echo

"正在采集第$page页..."

# echo " get_content: --->url:--->$1"

cResult =$(curl - -connect - timeout 10 -m 20 -k -s -L -A "$web_ua" "$1")

echo $cResult | grep - q

"采集"

# echo -e "$1\n$cResult"

if ["$?" = "0"]; then

next_content

"$cResult"

else

echo - e

"采集失败,请检查设置!\n失败链接-->$1\n返回信息-->$cResult\n采集结束,共0页"

fi

}

# 采集下页

function

next_content()

{

# 统计数据

Result =$(echo "$1" | tr "

" "\n")

a =$(echo "$Result" | grep -c "采集成功")

b =$(echo "$Result" | grep -c "更新数据")

c =$(echo "$Result" | grep -c "无需更新")

d =$(echo "$Result" | grep -c "跳过")

echo

"采集成功-->已更$c部,新增$a部,更新$b部,跳过$d部"

let

add +=$a

let

update +=$b

let

none +=$c

let

jmp +=$d

# 检测并采集下页

next_url =${1 ##*location.href=\'}

next_url =${next_url % %\'*}

# echo $next_url

if ["${next_url:0:1}" = "?"]

then

let

page + +

get_content

"$web_site$next_url"

else

echo

"采集结束,共$page页"

fi

}

# 脚本入口

echo

"海洋CMS自动采集脚本开始执行 版本:v1.2"

starttime =$(date +% s)

update = 0 # 更新

add = 0 # 新增

none = 0 # 无变化

jmp = 0 # 跳过

for url in ${web_api[@]};

do

if[[! -z $url]]

then

web_param="$web_site$url&password=$web_pwd"

page=1

echo "开始采集:$url"

get_content $web_param

fi

done

endtime=$(date + % s)

echo "============================"

echo "入库-->$add部"

echo "更新-->$update部"

echo "跳过-->$jmp部(未绑定分类或链接错误)"

echo "今日-->$[none+add+update]部"

echo "============================"

echo "全部采集结束,耗时$[endtime - starttime]秒"

Oceancms如何设置宝塔自动采集 第二步:修改脚本

[2] 脚本中的哪3项需要特别修改?让我为你一一讲述。 (根据上面提供的代码内容,复制到记事本或者其他html编辑器进行相应修改)

#①请修改下面的网站域名及管理目录

web_site="http://网站域名/管理目录/admin_reslib2.php"

这里要修改为你的“网站域名”和“seacmsbackground 管理目录”。每个人都可以理解域名。后端管理目录需要新手多说几句。首先,您必须能够登录到您的后端以了解您的后端目录。比如:如果我的后台登录地址是,那么这里的文章就是后台管理目录,拿到管理目录的时候直接填写代码即可。

#②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd="8888e82e85bd4540f0defa3fb7a8e888"

#③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

#每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api=(

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

这是代码中需要修改的最后一项。里面是代码中默认提供的两个采集链接地址。我们需要获取我们的采集 链接地址并将其添加到其中。关于获取链接地址的详细信息,请参见下面的屏幕截图。步操作。如果你还没有添加或者不知道如何添加采集,可以参考帮助文档-oceancms如何添加资源库采集interface

选择“后台-采集-资源库列表”,复制资源站右侧“采集今日”、“采集今日”、“采集全”的链接地址根据您的选择,并删除 ?之前的内容。 (当天或本周将鼠标移至采集,鼠标右击复制链接即可获得采集链接)

例如,这里是:

1

:///inc/ldg_seackm3u8s.php

第 2 步:删除“?”之前的内容复制上一步,结果如下:

2

?ac=day&rid=1&url=

这样就得到了最终的采集 URL

Oceancms如何设置宝塔自动采集 第三步:设置宝塔定时任务。

【3】直接将代码复制到宝塔计划任务的shell脚本中,并在内容中添加小时任务。具体步骤如下截图。步骤⑤是将我们修改后的脚本复制粘贴到脚本内容框中。

4] 总结

一般来说,在脚本中修改几个需要修改的项目后,将修改后的脚本复制到宝塔的定时任务设置中。安排采集task 就足够了。不要选择错误的任务类型。如果您对本教程不了解或有任何疑问,可以加入社区进行讨论和查询。 查看全部

自动采集网站内容(海洋cms怎么设置宝塔自动采集:获取脚本代码。)

Oceancms如何设置宝塔自动采集,因为很多人都在问这个问题,所以有这个教程。虽然oceancms给出了脚本代码,但是对于刚接触oceancms的用户来说,理解并不是那么容易。今天就详细介绍一下使用海洋cms自动采集的具体步骤。

Oceancms如何设置宝塔自动采集第一步:获取脚本代码。

[1] 以下是Oceancms官网提供的自动采集脚本代码。我们需要修改代码中的3项才可以使用。

#!/bin/bash

########################################################

# 程序名称: 海洋CMS自动采集脚本

# 版本信息:seacmsbot/ v2.0

# 发布链接: https://www.seacms.net/post-update-92579.htm

# 使用方法:直接复制代码到宝塔计划任务shell脚本内容里添加每小时任务使用

# 更新时间:2019.9.26

##########################################################

# ①请修改下面的网站域名及管理目录

web_site = "http://网站域名/管理目录/admin_reslib2.php"

# ②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd = "8888e82e85bd4540f0defa3fb7a8e888"

# ③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

# 每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api = (

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

# 模拟用户浏览器ua,请勿随意修改,以免被目标防火墙拦截!

web_ua = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko)

Chrome / 76.0

.3809

.100

Safari / 537.36

seacmsbot / 1.2;

"

# 采集单页

function

get_content()

{

echo

"正在采集第$page页..."

# echo " get_content: --->url:--->$1"

cResult =$(curl - -connect - timeout 10 -m 20 -k -s -L -A "$web_ua" "$1")

echo $cResult | grep - q

"采集"

# echo -e "$1\n$cResult"

if ["$?" = "0"]; then

next_content

"$cResult"

else

echo - e

"采集失败,请检查设置!\n失败链接-->$1\n返回信息-->$cResult\n采集结束,共0页"

fi

}

# 采集下页

function

next_content()

{

# 统计数据

Result =$(echo "$1" | tr "

" "\n")

a =$(echo "$Result" | grep -c "采集成功")

b =$(echo "$Result" | grep -c "更新数据")

c =$(echo "$Result" | grep -c "无需更新")

d =$(echo "$Result" | grep -c "跳过")

echo

"采集成功-->已更$c部,新增$a部,更新$b部,跳过$d部"

let

add +=$a

let

update +=$b

let

none +=$c

let

jmp +=$d

# 检测并采集下页

next_url =${1 ##*location.href=\'}

next_url =${next_url % %\'*}

# echo $next_url

if ["${next_url:0:1}" = "?"]

then

let

page + +

get_content

"$web_site$next_url"

else

echo

"采集结束,共$page页"

fi

}

# 脚本入口

echo

"海洋CMS自动采集脚本开始执行 版本:v1.2"

starttime =$(date +% s)

update = 0 # 更新

add = 0 # 新增

none = 0 # 无变化

jmp = 0 # 跳过

for url in ${web_api[@]};

do

if[[! -z $url]]

then

web_param="$web_site$url&password=$web_pwd"

page=1

echo "开始采集:$url"

get_content $web_param

fi

done

endtime=$(date + % s)

echo "============================"

echo "入库-->$add部"

echo "更新-->$update部"

echo "跳过-->$jmp部(未绑定分类或链接错误)"

echo "今日-->$[none+add+update]部"

echo "============================"

echo "全部采集结束,耗时$[endtime - starttime]秒"

Oceancms如何设置宝塔自动采集 第二步:修改脚本

[2] 脚本中的哪3项需要特别修改?让我为你一一讲述。 (根据上面提供的代码内容,复制到记事本或者其他html编辑器进行相应修改)

#①请修改下面的网站域名及管理目录

web_site="http://网站域名/管理目录/admin_reslib2.php"

这里要修改为你的“网站域名”和“seacmsbackground 管理目录”。每个人都可以理解域名。后端管理目录需要新手多说几句。首先,您必须能够登录到您的后端以了解您的后端目录。比如:如果我的后台登录地址是,那么这里的文章就是后台管理目录,拿到管理目录的时候直接填写代码即可。

#②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd="8888e82e85bd4540f0defa3fb7a8e888"

#③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

#每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api=(

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

这是代码中需要修改的最后一项。里面是代码中默认提供的两个采集链接地址。我们需要获取我们的采集 链接地址并将其添加到其中。关于获取链接地址的详细信息,请参见下面的屏幕截图。步操作。如果你还没有添加或者不知道如何添加采集,可以参考帮助文档-oceancms如何添加资源库采集interface

选择“后台-采集-资源库列表”,复制资源站右侧“采集今日”、“采集今日”、“采集全”的链接地址根据您的选择,并删除 ?之前的内容。 (当天或本周将鼠标移至采集,鼠标右击复制链接即可获得采集链接)

例如,这里是:

1

:///inc/ldg_seackm3u8s.php

第 2 步:删除“?”之前的内容复制上一步,结果如下:

2

?ac=day&rid=1&url=

这样就得到了最终的采集 URL

Oceancms如何设置宝塔自动采集 第三步:设置宝塔定时任务。

【3】直接将代码复制到宝塔计划任务的shell脚本中,并在内容中添加小时任务。具体步骤如下截图。步骤⑤是将我们修改后的脚本复制粘贴到脚本内容框中。

4] 总结

一般来说,在脚本中修改几个需要修改的项目后,将修改后的脚本复制到宝塔的定时任务设置中。安排采集task 就足够了。不要选择错误的任务类型。如果您对本教程不了解或有任何疑问,可以加入社区进行讨论和查询。

自动采集网站内容(网页中的表格数据指什么样子?如何做到批量采集100页或1000页)

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-09-01 07:17

这种需求似乎很少有人需要,但我认为总会有你需要的那一天。

网页中的表格数据是什么意思?

比如这个我今天要举的例子:

这个产品成分表只是一个数据表。

我们一般使用优采云采集器hard 采集等数据,保持原有结构。

还有优采云采集器,可以智能识别表格数据和采集,但是很多网站无法识别。在上面的示例中我无法识别这一点,因此无法识别采集。 .

但其实excel中有一个功能,就是采集网页中的表格,但是缺点是每次只能采集一页。如何批量处理采集100页或1000页数据?不能一个一个手动做吗?

试了试,最后还是用了excel的采集表格功能,不过我先采集把这100或1000页的内容,组成一个页面,可以被excel NS识别。

步骤如下:

1:优采云采集器采集必填页面

比如我先采集到这些页面的网址。

2、然后整理出来导入优采云采集器

这里注意,应该作为一级页面使用,否则会自动采集下级页面,优采云采集器老版本没有这个问题。

3、然后使用表格的部分html代码

这里是最简单的前后截取方式,采集获取内容,测试一下

获得这样的内容正是我们所需要的。

4、batch采集

然后保存任务,批处理采集就可以了。

5、采集complete

新版优采云采集器默认本地保存为sqlite数据库。没有旧版本的access数据库,所以在office里用access打开是不行的,但是可以用Navicat导入。

链接sqlite,然后选择我们采集到达的db3文件,打开确认。

获取以下数据。

6、Merge 采集来的数据

如果你不知道怎么把数据和数据库合并,也很简单,直接导出excel。

你会在excel中合并吗?即使没有,也只需选择要复制的列。

那我们贴出来看看吧。

获取一个这样的内容。

以 html 文件的形式直接保存到桌面。

7、excel 被识别为表格数据

我们选择excel中的数据-new query-since网站(我的excel版本用的是按钮不好用的红框)

然后填写刚才的html文件的本地地址并确认

Excel 会识别多种样式的数据,只需选择您想要的一种即可。

8、最终效果

我们得到的最终效果图就是这样的,因为我只有采集有72页,得到了1600行数据。

到这里,你就完成了。 查看全部

自动采集网站内容(网页中的表格数据指什么样子?如何做到批量采集100页或1000页)

这种需求似乎很少有人需要,但我认为总会有你需要的那一天。

网页中的表格数据是什么意思?

比如这个我今天要举的例子:

这个产品成分表只是一个数据表。

我们一般使用优采云采集器hard 采集等数据,保持原有结构。

还有优采云采集器,可以智能识别表格数据和采集,但是很多网站无法识别。在上面的示例中我无法识别这一点,因此无法识别采集。 .

但其实excel中有一个功能,就是采集网页中的表格,但是缺点是每次只能采集一页。如何批量处理采集100页或1000页数据?不能一个一个手动做吗?

试了试,最后还是用了excel的采集表格功能,不过我先采集把这100或1000页的内容,组成一个页面,可以被excel NS识别。

步骤如下:

1:优采云采集器采集必填页面

比如我先采集到这些页面的网址。

2、然后整理出来导入优采云采集器

这里注意,应该作为一级页面使用,否则会自动采集下级页面,优采云采集器老版本没有这个问题。

3、然后使用表格的部分html代码

这里是最简单的前后截取方式,采集获取内容,测试一下

获得这样的内容正是我们所需要的。

4、batch采集

然后保存任务,批处理采集就可以了。

5、采集complete

新版优采云采集器默认本地保存为sqlite数据库。没有旧版本的access数据库,所以在office里用access打开是不行的,但是可以用Navicat导入。

链接sqlite,然后选择我们采集到达的db3文件,打开确认。

获取以下数据。

6、Merge 采集来的数据

如果你不知道怎么把数据和数据库合并,也很简单,直接导出excel。

你会在excel中合并吗?即使没有,也只需选择要复制的列。

那我们贴出来看看吧。

获取一个这样的内容。

以 html 文件的形式直接保存到桌面。

7、excel 被识别为表格数据

我们选择excel中的数据-new query-since网站(我的excel版本用的是按钮不好用的红框)

然后填写刚才的html文件的本地地址并确认

Excel 会识别多种样式的数据,只需选择您想要的一种即可。

8、最终效果

我们得到的最终效果图就是这样的,因为我只有采集有72页,得到了1600行数据。

到这里,你就完成了。

自动采集网站内容(自动采集网站内容一般用zxing,可以直接生成pdf文件阅读)

采集交流 • 优采云 发表了文章 • 0 个评论 • 138 次浏览 • 2021-08-30 13:00

自动采集网站内容一般用zxing,语法应该是f2f2f2f2这样的,然后正则表达式用xpath,

用gephi,利用gephi可以很方便做出自己想要的网站内容分析图表。

如果想要数据通过网页传输,网站也要可以浏览的话,

快速采集各大门户网站内容,推荐photopaste。采集完成后可以直接生成pdf文件阅读,

pageminer

其实我们就用pageminer。可以把其中的页面网站采集下来。可以拖拽采集,也可以gif动图采集。采集完直接保存在csv里,但没有合理的分组,查找页面间的关系,整理起来特别困难。

采集各大网站内容,推荐pageminer,采集完成后可以直接生成pdf文件阅读,功能很强大,配合spring,可以快速收集大数据量。

常用的两个是extractor和workmap

如果是采集国内网站,pageminer很不错。如果是国外网站,推荐nemesis和pagelight,可以采集下载,但是不会在浏览器上显示。

pagemate,不需要编程,可以采集网页中的内容,

zxing+gephi

可以自己搭建一个采集网站源代码的工具。

快速采集网站内容,强烈推荐zxing!可以提取网站的内容, 查看全部

自动采集网站内容(自动采集网站内容一般用zxing,可以直接生成pdf文件阅读)

自动采集网站内容一般用zxing,语法应该是f2f2f2f2这样的,然后正则表达式用xpath,

用gephi,利用gephi可以很方便做出自己想要的网站内容分析图表。

如果想要数据通过网页传输,网站也要可以浏览的话,

快速采集各大门户网站内容,推荐photopaste。采集完成后可以直接生成pdf文件阅读,

pageminer

其实我们就用pageminer。可以把其中的页面网站采集下来。可以拖拽采集,也可以gif动图采集。采集完直接保存在csv里,但没有合理的分组,查找页面间的关系,整理起来特别困难。

采集各大网站内容,推荐pageminer,采集完成后可以直接生成pdf文件阅读,功能很强大,配合spring,可以快速收集大数据量。

常用的两个是extractor和workmap

如果是采集国内网站,pageminer很不错。如果是国外网站,推荐nemesis和pagelight,可以采集下载,但是不会在浏览器上显示。

pagemate,不需要编程,可以采集网页中的内容,

zxing+gephi

可以自己搭建一个采集网站源代码的工具。

快速采集网站内容,强烈推荐zxing!可以提取网站的内容,

自动采集网站内容(本篇文章我教大家如何获取Cookies登录状态是通过Cookies判定的)

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2021-08-29 18:03

在这篇文章中文章我教你如何采集需要登录网站并自动下载其资源。

获取 Cookie

登录状态由Cookies决定,所以先登录目标网站,按F12打开开发者工具,将Cookies复制到剪贴板如下图。

然后在QQWorld采集器的采集品中新建一个,将复制的Cookies代码粘贴到Cookies输入框中:

设置采集rule 常规设置

设置采集 列表链接、文章 标题和文章 内容选择器。这些都比较简单,这里不再赘述。不明白的请参考QQWorld采集器旗舰采集教程。

采集download 资源

因为填充了cookies,所以在爬取的网页内容中可以看到下载地址的代码,如图:

因为onclick属性中有多余的代码,只用引号括起来的内容就够了,所以要使用正则表达式采集,新建一个自定义列采集,设置方法如图图:

这里设置下载地址保存在win-down自定义列中,由于采集到达的地址是相对地址,需要根据完整地址加前缀。然后检查下载到本地目录。也可以勾选下载到媒体库,但首先要确保Wordpress媒体库允许上传这种格式。

格式文章content

大部分用户不会修改模板,所以不知道如何输出这个下载地址。 QQWorld 采集器提供文章content 格式化工具。在采集项的自动采集设置中,如下图设置:

可以使用四个短代码,分别代表文章content、文章title、文章custom 列和超链接。在自定义列简码的key属性中填写win-down输出下载地址。

结论

遗憾的是,需要付费的内容不能是采集。没有办法做到这一点。

教程到此结束。此功能应适用于广泛的应用程序。有很多用户需要登录下载网站,等我们去采集。还没用的朋友还在等什么?立即试用:QQWorld 采集器。 查看全部

自动采集网站内容(本篇文章我教大家如何获取Cookies登录状态是通过Cookies判定的)

在这篇文章中文章我教你如何采集需要登录网站并自动下载其资源。

获取 Cookie

登录状态由Cookies决定,所以先登录目标网站,按F12打开开发者工具,将Cookies复制到剪贴板如下图。

https://www.qqworld.org/wp-con ... 0.png 300w, https://www.qqworld.org/wp-con ... 1.png 768w, https://www.qqworld.org/wp-con ... s.png 1055w" />

https://www.qqworld.org/wp-con ... 0.png 300w, https://www.qqworld.org/wp-con ... 1.png 768w, https://www.qqworld.org/wp-con ... s.png 1055w" />然后在QQWorld采集器的采集品中新建一个,将复制的Cookies代码粘贴到Cookies输入框中:

https://www.qqworld.org/wp-con ... 7.png 300w, https://www.qqworld.org/wp-con ... 6.png 768w" />

https://www.qqworld.org/wp-con ... 7.png 300w, https://www.qqworld.org/wp-con ... 6.png 768w" />设置采集rule 常规设置

设置采集 列表链接、文章 标题和文章 内容选择器。这些都比较简单,这里不再赘述。不明白的请参考QQWorld采集器旗舰采集教程。

采集download 资源

因为填充了cookies,所以在爬取的网页内容中可以看到下载地址的代码,如图:

https://www.qqworld.org/wp-con ... 3.png 300w" />

https://www.qqworld.org/wp-con ... 3.png 300w" />因为onclick属性中有多余的代码,只用引号括起来的内容就够了,所以要使用正则表达式采集,新建一个自定义列采集,设置方法如图图:

https://www.qqworld.org/wp-con ... 3.png 300w, https://www.qqworld.org/wp-con ... 5.png 768w, https://www.qqworld.org/wp-con ... t.png 1375w" />

https://www.qqworld.org/wp-con ... 3.png 300w, https://www.qqworld.org/wp-con ... 5.png 768w, https://www.qqworld.org/wp-con ... t.png 1375w" />这里设置下载地址保存在win-down自定义列中,由于采集到达的地址是相对地址,需要根据完整地址加前缀。然后检查下载到本地目录。也可以勾选下载到媒体库,但首先要确保Wordpress媒体库允许上传这种格式。

格式文章content

大部分用户不会修改模板,所以不知道如何输出这个下载地址。 QQWorld 采集器提供文章content 格式化工具。在采集项的自动采集设置中,如下图设置:

https://www.qqworld.org/wp-con ... 0.png 300w, https://www.qqworld.org/wp-con ... 5.png 768w" />

https://www.qqworld.org/wp-con ... 0.png 300w, https://www.qqworld.org/wp-con ... 5.png 768w" />可以使用四个短代码,分别代表文章content、文章title、文章custom 列和超链接。在自定义列简码的key属性中填写win-down输出下载地址。

结论

遗憾的是,需要付费的内容不能是采集。没有办法做到这一点。

教程到此结束。此功能应适用于广泛的应用程序。有很多用户需要登录下载网站,等我们去采集。还没用的朋友还在等什么?立即试用:QQWorld 采集器。

自动采集网站内容(自动采集网站内容的网站有不少,怎么办?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-08-29 15:02

自动采集网站内容的网站有不少,我目前知道的包括站长之家,众成翻译,西瓜翻译等等。如果你要自己采集网站内容,那就需要多研究网站,每天上去看看信息的更新,可以做一些标注和记录。如果是需要免费网站内容的话,那有一个叫谷歌翻译的网站可以免费帮助你。当然,请花费些时间去辨别和判断下。

我们可以做一个网站专门去找翻译,数量不多,1.2w左右。

考虑语言方面的多一些,

百度的网站爬虫有时抓取不了,就是这么麻烦,我们目前可以从百度搜索引擎获取到10.6万篇来自全球各地的文章!有需要的话可以私信我。

google翻译吧,用着比较简单,这也是我们网站去搬砖的主要工具。也是仅有的一个可以把大量外文文章翻译成中文的网站。

freeextractor

外网翻译网,可以把国外网站翻译成中文,

你可以搜索一下附近有没有机构做谷歌翻译,不过应该是花钱去买的,如果没有免费的机构,我估计没几个能把内容全部翻译出来。

transferwise还有transferwiseyahoo

专业办事情的网站,阿拉丁网,你可以搜一下,