自动采集网站内容

自动采集网站内容(v3.0.2.6绿色版数据收集工具.测评)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2021-11-18 13:11

优采云采集器v3.0.2.6 绿色版强大的数据采集工具,软件提供专业的采集功能,使用绿色版优采云采集器v3.0.2.6,可以帮助用户从网页中采集各种数据,自动生成Excel表格和API数据库 用户可以随时查看数据等。软件目前支持大部分网站,有需要的朋友快来下载吧!

优采云采集器亮点

1、向导模式

易于使用,只需单击鼠标即可轻松自动生成脚本。

2、定时操作

可按计划定期运行,无需人工操作。

3、原装高速内核

自主研发的浏览器内核速度极快,远超对手。

4、智能识别

可以智能识别网页中的列表和表单结构(多选框下拉列表等)。

5、广告拦截

自定义广告拦截模块,兼容AdblockPlus语法,可添加自定义规则。

6、多数据导出

支持 Txt、Excel、MySQL、SQLServer、SQlite、Access、网站 等

优采云采集器优点

1、一键数据提取:简单易学,通过可视化界面,鼠标点击即可抓取数据。

2、快速高效:内置一套高速浏览器内核,加上HTTP引擎模式,实现快速采集数据。

3、适用于各种网站:网站能够采集99%的互联网,包括单页应用、Ajax加载等动态类型网站 .

4、 导出数据的种类很多。可以将采集中的数据导出到Csv、Excel以及各种数据库,并支持api导出。

综合评价

优采云采集器为用户提供有用的数据采集服务,功能强大,操作简单,还可以设置让软件如期定时运行,无需人工操作非常方便。 查看全部

自动采集网站内容(v3.0.2.6绿色版数据收集工具.测评)

优采云采集器v3.0.2.6 绿色版强大的数据采集工具,软件提供专业的采集功能,使用绿色版优采云采集器v3.0.2.6,可以帮助用户从网页中采集各种数据,自动生成Excel表格和API数据库 用户可以随时查看数据等。软件目前支持大部分网站,有需要的朋友快来下载吧!

优采云采集器亮点

1、向导模式

易于使用,只需单击鼠标即可轻松自动生成脚本。

2、定时操作

可按计划定期运行,无需人工操作。

3、原装高速内核

自主研发的浏览器内核速度极快,远超对手。

4、智能识别

可以智能识别网页中的列表和表单结构(多选框下拉列表等)。

5、广告拦截

自定义广告拦截模块,兼容AdblockPlus语法,可添加自定义规则。

6、多数据导出

支持 Txt、Excel、MySQL、SQLServer、SQlite、Access、网站 等

优采云采集器优点

1、一键数据提取:简单易学,通过可视化界面,鼠标点击即可抓取数据。

2、快速高效:内置一套高速浏览器内核,加上HTTP引擎模式,实现快速采集数据。

3、适用于各种网站:网站能够采集99%的互联网,包括单页应用、Ajax加载等动态类型网站 .

4、 导出数据的种类很多。可以将采集中的数据导出到Csv、Excel以及各种数据库,并支持api导出。

综合评价

优采云采集器为用户提供有用的数据采集服务,功能强大,操作简单,还可以设置让软件如期定时运行,无需人工操作非常方便。

自动采集网站内容(无人值守全自动采集器(EditorTools)功能特色:中小网站自动更新利器)

采集交流 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2021-11-18 13:10

EditorTools 是一款无人值守的全自动采集器,非常值得所有站长朋友们使用。可以帮助用户解决中小型网站和企业站的自动信息。采集操作,更智能的采集程序保证您的网站内容更新质量及时@网站! EditorTools的出现将为站长和管理会员节省大量时间,从繁琐枯燥的网站更新工作中解放出来!

EditorTools——中小型网站自动更新工具!

声明:本软件适用于需要长期更新内容的非临时网站使用,不需要您对现有论坛或网站进行任何改动。

无人值守的自动 采集器(EditorTools) 功能:

1、独特的无人值守操作

ET从设计之初就以提高软件自动化程度为突破口,以达到无人值守、24小时自动化工作的目的。经测试,ET可以长时间自动运行,即使时间单位是年。

2、超高稳定性

如果软件要无人值守,需要长期稳定运行。 ET在这方面做了很多优化,保证软件可以稳定连续运行,不会出现软件采集。自身的崩溃甚至导致了网站崩溃的问题。

3、最小资源占用

ET独立于网站,不消耗宝贵的服务器WEB处理资源。它可以在服务器上运行,也可以在站长的工作站上运行。

4、严格的数据和网络安全

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免了ET可能带来的数据安全问题. 采集 供参考,ET使用标准的HTTP端口,不会造成网络安全漏洞。

5、强大灵活的功能

ET除了一般采集工具的功能外,还使用了图片水印、防盗、分页采集、回复采集、登录采集、自定义项, UTF-8、UBB, 模拟发布...支持,让用户可以灵活实现多种采购需求。

v3.2.1 更新内容:

1、修正:选择数据项作为文件时,分隔符无效的问题。 查看全部

自动采集网站内容(无人值守全自动采集器(EditorTools)功能特色:中小网站自动更新利器)

EditorTools 是一款无人值守的全自动采集器,非常值得所有站长朋友们使用。可以帮助用户解决中小型网站和企业站的自动信息。采集操作,更智能的采集程序保证您的网站内容更新质量及时@网站! EditorTools的出现将为站长和管理会员节省大量时间,从繁琐枯燥的网站更新工作中解放出来!

EditorTools——中小型网站自动更新工具!

声明:本软件适用于需要长期更新内容的非临时网站使用,不需要您对现有论坛或网站进行任何改动。

无人值守的自动 采集器(EditorTools) 功能:

1、独特的无人值守操作

ET从设计之初就以提高软件自动化程度为突破口,以达到无人值守、24小时自动化工作的目的。经测试,ET可以长时间自动运行,即使时间单位是年。

2、超高稳定性

如果软件要无人值守,需要长期稳定运行。 ET在这方面做了很多优化,保证软件可以稳定连续运行,不会出现软件采集。自身的崩溃甚至导致了网站崩溃的问题。

3、最小资源占用

ET独立于网站,不消耗宝贵的服务器WEB处理资源。它可以在服务器上运行,也可以在站长的工作站上运行。

4、严格的数据和网络安全

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免了ET可能带来的数据安全问题. 采集 供参考,ET使用标准的HTTP端口,不会造成网络安全漏洞。

5、强大灵活的功能

ET除了一般采集工具的功能外,还使用了图片水印、防盗、分页采集、回复采集、登录采集、自定义项, UTF-8、UBB, 模拟发布...支持,让用户可以灵活实现多种采购需求。

v3.2.1 更新内容:

1、修正:选择数据项作为文件时,分隔符无效的问题。

自动采集网站内容(原有(php+mysql)新闻系统v1.1学习了)

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-11-17 15:23

YYcms(php+mysql)新闻系统修改版v1.1 学习asp好几年了,现在转用php,但是一直没有找到合适的学习系统。这个很容易使用。在原有的基础上,做了一些有益的尝试,但在后台还存在一些不足。. . 例如:新闻不按类别显示。修改新闻时无法自动识别栏目等。附上修改前的代码08.shtml。大家对比学习,希望大家一起学习进步~ 联系邮箱: 安装方法:在phpmyadmin中新建一个数据库“aozoweb99”,(代码gb2312)然后导入数据文件下的sql文件;请导入最新的数据库: 查看全部

自动采集网站内容(原有(php+mysql)新闻系统v1.1学习了)

YYcms(php+mysql)新闻系统修改版v1.1 学习asp好几年了,现在转用php,但是一直没有找到合适的学习系统。这个很容易使用。在原有的基础上,做了一些有益的尝试,但在后台还存在一些不足。. . 例如:新闻不按类别显示。修改新闻时无法自动识别栏目等。附上修改前的代码08.shtml。大家对比学习,希望大家一起学习进步~ 联系邮箱: 安装方法:在phpmyadmin中新建一个数据库“aozoweb99”,(代码gb2312)然后导入数据文件下的sql文件;请导入最新的数据库:

自动采集网站内容(你可以用windows下的extract方法来写你要的类型)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-11-16 03:03

自动采集网站内容:phpwind--extractyourcontent你好,你不需要用到phpwind。extractcontentshouldnotbesignedfromstaticfilestoyourshort-livemarketplace.itisoptionalforyoutoopenfilestoyourcontentcenterwithoutrespect.createabrowserinwhichextractfilesdon'tneedtoresolveandcompressitbutit'sapassivefeature,plusfail.简单地说,phpwind不是用来用来采集网站内容的。

对于extract语句,使用的是fopen(file,stdout,"inline");目前在windows的环境下,基本上,工具软件不都支持fopen么?你可以用windows下的extract方法来写你要的类型,基本上可以很方便地处理网页内容。现在xampp也支持配置fopen,不过这个方法只是在windows下工作,安卓,ios不支持。

另外在windows下如果你喜欢用手动命令来做采集,你可以用fcgi,不过你采集之后要加很多事,比如fromtag(,template),把所有的article都放到一个文件,然后再起个fopen就行了,而且guest账户不能直接上传文件。(回答主要针对的就是是extract,不是说这个类型的采集器不好。)。 查看全部

自动采集网站内容(你可以用windows下的extract方法来写你要的类型)

自动采集网站内容:phpwind--extractyourcontent你好,你不需要用到phpwind。extractcontentshouldnotbesignedfromstaticfilestoyourshort-livemarketplace.itisoptionalforyoutoopenfilestoyourcontentcenterwithoutrespect.createabrowserinwhichextractfilesdon'tneedtoresolveandcompressitbutit'sapassivefeature,plusfail.简单地说,phpwind不是用来用来采集网站内容的。

对于extract语句,使用的是fopen(file,stdout,"inline");目前在windows的环境下,基本上,工具软件不都支持fopen么?你可以用windows下的extract方法来写你要的类型,基本上可以很方便地处理网页内容。现在xampp也支持配置fopen,不过这个方法只是在windows下工作,安卓,ios不支持。

另外在windows下如果你喜欢用手动命令来做采集,你可以用fcgi,不过你采集之后要加很多事,比如fromtag(,template),把所有的article都放到一个文件,然后再起个fopen就行了,而且guest账户不能直接上传文件。(回答主要针对的就是是extract,不是说这个类型的采集器不好。)。

自动采集网站内容(自动采集网站内容是现在开始做seo必须要知道的一项)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-11-14 07:01

自动采集网站内容是现在开始做seo必须要知道的一项。1,自动采集网站内容的步骤:第一步,先用wordpress提供的客户端软件,如:indexpress,extress,phphome和onlinesite,编写一段自动采集网站内容的代码,如下例所示(该教程注释非常好,值得看)第二步,采集来的网站内容直接存储在html语句中,或者放到后台网站文件的meta信息文件中,标识如下第三步,登录,点击”保存“第四步,选择一个”sitemap“地图,一定要选择内容区域第五步,可能你要选择”文章“、”页面“、”文章页面“、“文章页面指定id”这些,当然还有其他你自己选择的,总之有了指定的就更好了。

第六步,当你看到想要采集的内容,你就开始操作吧。如上图所示。自动采集网站内容是seo站长中非常重要的一环,你不会采集网站内容,对seo起不到任何作用,甚至会对你产生误导作用。只要会写点代码的基本都可以完成,不需要去找别人定制。(这样还会导致有人写各种代码,非常冗长而且不专业,把页面的某些地方搞得杂乱无章)自动采集一个网站内容需要上面六步,一点点定制化去完成。

如果你已经有网站了,并且已经有多页了,就应该去适应不同的页面。一个页面采集,还会有页面之间的内容互相跳转。

我自己有个工作室,可以帮你提供一个全部网站内容数据采集系统。可以自动采集301页数据,采集300篇文章数据。 查看全部

自动采集网站内容(自动采集网站内容是现在开始做seo必须要知道的一项)

自动采集网站内容是现在开始做seo必须要知道的一项。1,自动采集网站内容的步骤:第一步,先用wordpress提供的客户端软件,如:indexpress,extress,phphome和onlinesite,编写一段自动采集网站内容的代码,如下例所示(该教程注释非常好,值得看)第二步,采集来的网站内容直接存储在html语句中,或者放到后台网站文件的meta信息文件中,标识如下第三步,登录,点击”保存“第四步,选择一个”sitemap“地图,一定要选择内容区域第五步,可能你要选择”文章“、”页面“、”文章页面“、“文章页面指定id”这些,当然还有其他你自己选择的,总之有了指定的就更好了。

第六步,当你看到想要采集的内容,你就开始操作吧。如上图所示。自动采集网站内容是seo站长中非常重要的一环,你不会采集网站内容,对seo起不到任何作用,甚至会对你产生误导作用。只要会写点代码的基本都可以完成,不需要去找别人定制。(这样还会导致有人写各种代码,非常冗长而且不专业,把页面的某些地方搞得杂乱无章)自动采集一个网站内容需要上面六步,一点点定制化去完成。

如果你已经有网站了,并且已经有多页了,就应该去适应不同的页面。一个页面采集,还会有页面之间的内容互相跳转。

我自己有个工作室,可以帮你提供一个全部网站内容数据采集系统。可以自动采集301页数据,采集300篇文章数据。

自动采集网站内容(editortools网站采集软件软件()(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-11-12 14:11

软件标签:editortools 网站采集软件

编辑工具软件是一款自动采集信息软件。用户只需下载安装即可开始使用。可自动管理采集网站中的信息,智能管理信息内容和更新,为用户的网站管理工作提供极大的便利,提高工作效率。有兴趣的朋友快来下载体验吧!

编辑器工具介绍:

<p>编辑器工具是一款无人值守的全自动采集器,非常值得站长朋友们使用。可以帮助用户解决中小型网站和企业站的自动信息。采集操作,更智能的采集程序保证您的 查看全部

自动采集网站内容( 引起网站被封的原因是什么?如何解决网站封)

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-11-12 13:07

引起网站被封的原因是什么?如何解决网站封)

<IMG border="1" height=320 src="http://photocdn.sohu.com/20131 ... ot%3B width=480 alt="一、什么是网站被封">

一、什么是网站被屏蔽了

网站被屏蔽,也称网站被K。指输入:在搜索引擎中,搜索结果显示为:抱歉,没有找到与“”相关的网页。换句话说,您在搜索引擎中找不到您的 网站 上的任何网页。

二、导致网站被屏蔽

1、不健康或非法内容

一些非法的网站如赌博、反动的网站,还有一些边缘球网站如美容、影视音乐等网站,这些网站目前是不允许做的,所以很容易被搜索引擎查封。另外,网站上不要有大量被禁止的关键词,搜索引擎会认为存在大量非法内容,导致被屏蔽。

解决策略:更改网站的主题,或者删除网站上的非法内容。

2、大量群发外链

群发外链是指短时间内大量添加外链。这些外链一般都是用软件实现的,内容也差不多。搜索引擎禁止此类外链群发布。一旦被发现,他们将被阻止。站处理。

解决策略:使用形式化的方法来操作外链,外链应该是均匀自然的增加,不要短时间内大量增加。

3、网站团建

网站群建是指大量的主题相似的网站。一般使用软件进行采集批量更新维护。同时,站点之间存在链接,很多站点都在同一个IP服务器下。此行为也被搜索引擎阻止。

解决策略:尽量不要放在同一个IP服务器上,站点之间不要互通,同时控制内容,避免大量采集垃圾邮件,控制网站数量,让搜索引擎认为这是一个自然站点。

4、 被屏蔽的友情链接牵连

交换友情链接时请注意,如果链接被屏蔽网站,您的网站也会受到牵连。

解决策略:定期用友情链检查工具检查,发现收录为0的站点,应及时删除。

5、隐藏锚文本链接

隐藏文字链接是指网站页面上存在大量含有关键词的文字或链接。这些文字和链接是肉眼不可见的,与网站的背景颜色相同。如果您的网站有大量隐藏链接,被搜索引擎发现后处理会更加严重。

解决策略:去除隐藏链接。

6、大量采集内容站点

采集内容站是指利用软件自动更新,网站的内容是互联网上存在的重复页面。此类网站在被搜索引擎发现后将被屏蔽。

解决策略:手动更新,对来自采集的内容进行简单处理。

7、服务器IP问题

检查与您的 网站 具有相同 IP 的其他站点。如果大量站点没有收录,可能是服务器IP问题,可能被搜索引擎拉入黑名单。

解决策略:改变IP空间

8、域名问题

分析日志可以发现,如果蜘蛛基本不来,或者来的很少,一般是域名问题。有可能是域名被屏蔽,被搜索引擎列入黑名单。

解决策略:更改域名

9、没有内容的单页站点

一些单页、广告页、导航站点站点只有一页,没有实质内容。这样的网站搜索引擎不容易收录

解决策略:在单页站点一级目录下创建博客,每天更新内容。

11、搜索引擎自身原因

也有搜索引擎出错的时候。Internet 上的网页数量是巨大的。不可能收录所有站点。有时数据库在调整过程中会出现问题。如果大量站点被屏蔽,不要惊慌,很有可能。是搜索引擎本身的问题。你可以等待一段时间,它自然会出现。

解决策略:等待,时间问题。

三、解决网站被屏蔽的日常步骤

第 1 步:了解网站被阻止的常见原因

第二步:列出自己网站可能被屏蔽的所有可能情况

第三步:对每一种情况一一分析消除

第四步:每天保持更新,发布原创文章,增加外链等三方面的工作

网站SEO优化是一个不断变化的过程。经验是第一位的,心态也是很基础的。除了对这个行业充满热情和自信,我们还需要多学习、多实践、多交流! 查看全部

自动采集网站内容(

引起网站被封的原因是什么?如何解决网站封)

<IMG border="1" height=320 src="http://photocdn.sohu.com/20131 ... ot%3B width=480 alt="一、什么是网站被封">

一、什么是网站被屏蔽了

网站被屏蔽,也称网站被K。指输入:在搜索引擎中,搜索结果显示为:抱歉,没有找到与“”相关的网页。换句话说,您在搜索引擎中找不到您的 网站 上的任何网页。

二、导致网站被屏蔽

1、不健康或非法内容

一些非法的网站如赌博、反动的网站,还有一些边缘球网站如美容、影视音乐等网站,这些网站目前是不允许做的,所以很容易被搜索引擎查封。另外,网站上不要有大量被禁止的关键词,搜索引擎会认为存在大量非法内容,导致被屏蔽。

解决策略:更改网站的主题,或者删除网站上的非法内容。

2、大量群发外链

群发外链是指短时间内大量添加外链。这些外链一般都是用软件实现的,内容也差不多。搜索引擎禁止此类外链群发布。一旦被发现,他们将被阻止。站处理。

解决策略:使用形式化的方法来操作外链,外链应该是均匀自然的增加,不要短时间内大量增加。

3、网站团建

网站群建是指大量的主题相似的网站。一般使用软件进行采集批量更新维护。同时,站点之间存在链接,很多站点都在同一个IP服务器下。此行为也被搜索引擎阻止。

解决策略:尽量不要放在同一个IP服务器上,站点之间不要互通,同时控制内容,避免大量采集垃圾邮件,控制网站数量,让搜索引擎认为这是一个自然站点。

4、 被屏蔽的友情链接牵连

交换友情链接时请注意,如果链接被屏蔽网站,您的网站也会受到牵连。

解决策略:定期用友情链检查工具检查,发现收录为0的站点,应及时删除。

5、隐藏锚文本链接

隐藏文字链接是指网站页面上存在大量含有关键词的文字或链接。这些文字和链接是肉眼不可见的,与网站的背景颜色相同。如果您的网站有大量隐藏链接,被搜索引擎发现后处理会更加严重。

解决策略:去除隐藏链接。

6、大量采集内容站点

采集内容站是指利用软件自动更新,网站的内容是互联网上存在的重复页面。此类网站在被搜索引擎发现后将被屏蔽。

解决策略:手动更新,对来自采集的内容进行简单处理。

7、服务器IP问题

检查与您的 网站 具有相同 IP 的其他站点。如果大量站点没有收录,可能是服务器IP问题,可能被搜索引擎拉入黑名单。

解决策略:改变IP空间

8、域名问题

分析日志可以发现,如果蜘蛛基本不来,或者来的很少,一般是域名问题。有可能是域名被屏蔽,被搜索引擎列入黑名单。

解决策略:更改域名

9、没有内容的单页站点

一些单页、广告页、导航站点站点只有一页,没有实质内容。这样的网站搜索引擎不容易收录

解决策略:在单页站点一级目录下创建博客,每天更新内容。

11、搜索引擎自身原因

也有搜索引擎出错的时候。Internet 上的网页数量是巨大的。不可能收录所有站点。有时数据库在调整过程中会出现问题。如果大量站点被屏蔽,不要惊慌,很有可能。是搜索引擎本身的问题。你可以等待一段时间,它自然会出现。

解决策略:等待,时间问题。

三、解决网站被屏蔽的日常步骤

第 1 步:了解网站被阻止的常见原因

第二步:列出自己网站可能被屏蔽的所有可能情况

第三步:对每一种情况一一分析消除

第四步:每天保持更新,发布原创文章,增加外链等三方面的工作

网站SEO优化是一个不断变化的过程。经验是第一位的,心态也是很基础的。除了对这个行业充满热情和自信,我们还需要多学习、多实践、多交流!

自动采集网站内容(网页表格数据采集助手的使用方法及使用方法介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-11-09 13:13

网页表单数据采集助手是一种可以采集单页规则和不规则表单的表单,也可以自动连续采集指定网站的表单,并且您可以指定采集 所需字段的内容。

相关软件软件大小版本说明下载地址

网页表单数据采集助手是一种可以采集单页规则和不规则表单的表单,也可以自动连续采集指定网站的表单,此外,您可以指定采集 所需字段的内容。采集后的内容既可以保存为EXCEL软件可以读取的文件格式,也可以保存为保留原格式的纯文本格式,绝对简单、方便、快捷、纯绿色。如果您不相信,只需下载并尝试一下。

指示

1、首先在地址栏中输入网页地址为采集。如果要采集的网页已经在IE浏览器中打开,则软件URL列表

这个地址会自动添加,你只需要下拉选择它就会打开。

2、 然后点击爬虫测试按钮,可以看到网页源代码和网页收录的表数。网页源代码显示在软件下方的文本框中。

页面收录的表格数量和页眉信息显示在软件左上角的列表框中。

3、从表号列表中选择要抓取的表,在软件表左上角的第一个框中会显示该表左上角的第一个文本

在输入框中,表单中收录的字段(列)将显示在软件左侧的中间列表中。

4、 然后选择你要采集的表数据的字段(列),如果不选择,都是采集。

5、选择是否要抓取表格的标题行,保存时是否显示表格行。如果网页表单中有带有链接的字段,您可以选择是否

包括链接地址。如果你有并且想要采集它的链接地址,那么你不能同时选择收录标题行。

6、如果你想让采集只有一个网页的表格数据,那么你可以点击抓取表格直接抓取它,如果你之前没有选择收录表格

网格、表格数据会以CVS格式保存,这种格式可以直接用微软EXCEL软件打开转换成EXCEL表格,如果选择在前面收录表格

网格线和表格数据会以TXT格式保存,可以用记事本软件打开查看,表格线直接可用,也很清晰。

7、如果想让采集的表单数据有多个连续的页面,并且想要采集向下,那么请重新设置程序采集下一页并后部

继续页面的方式可以是根据链接名称打开下一个页面。几乎大多数页面的链接名称都是“下一页”。您查看页面并找到它。

只要输入它。如果网页没有下一页的链接,但是URL中收录了页数,那么您也可以根据URL中的页数选择打开,您可以

要从前到后选择,例如从第 1 页到第 10 页,或从后到前,例如从第 10 页到第 1 页,请在页码输入框中输入,但此时

URL中代表页数的位置要用“(*)”代替,否则程序将无法识别。

8、 然后选择定时采集或者等待网页打开加载采集后立即加载,定时采集是程序设置的一个很小的时间间隔

判断打开的页面中是否有你想要的表单,采集如果有,采集页面加载后,只要采集的页面已经打开,

程序会立即进行采集,两者各有特点,视需要选择。

9、最后,你只需要点击抢表按钮,就可以泡杯咖啡了!

10、如果你已经熟悉了要采集的网页信息,并且想要采集指定表单中的所有字段,也可以输入需要的一

一些信息后,直接点击抓取表格,无需经过爬取测试等操作。 查看全部

自动采集网站内容(网页表格数据采集助手的使用方法及使用方法介绍)

网页表单数据采集助手是一种可以采集单页规则和不规则表单的表单,也可以自动连续采集指定网站的表单,并且您可以指定采集 所需字段的内容。

相关软件软件大小版本说明下载地址

网页表单数据采集助手是一种可以采集单页规则和不规则表单的表单,也可以自动连续采集指定网站的表单,此外,您可以指定采集 所需字段的内容。采集后的内容既可以保存为EXCEL软件可以读取的文件格式,也可以保存为保留原格式的纯文本格式,绝对简单、方便、快捷、纯绿色。如果您不相信,只需下载并尝试一下。

指示

1、首先在地址栏中输入网页地址为采集。如果要采集的网页已经在IE浏览器中打开,则软件URL列表

这个地址会自动添加,你只需要下拉选择它就会打开。

2、 然后点击爬虫测试按钮,可以看到网页源代码和网页收录的表数。网页源代码显示在软件下方的文本框中。

页面收录的表格数量和页眉信息显示在软件左上角的列表框中。

3、从表号列表中选择要抓取的表,在软件表左上角的第一个框中会显示该表左上角的第一个文本

在输入框中,表单中收录的字段(列)将显示在软件左侧的中间列表中。

4、 然后选择你要采集的表数据的字段(列),如果不选择,都是采集。

5、选择是否要抓取表格的标题行,保存时是否显示表格行。如果网页表单中有带有链接的字段,您可以选择是否

包括链接地址。如果你有并且想要采集它的链接地址,那么你不能同时选择收录标题行。

6、如果你想让采集只有一个网页的表格数据,那么你可以点击抓取表格直接抓取它,如果你之前没有选择收录表格

网格、表格数据会以CVS格式保存,这种格式可以直接用微软EXCEL软件打开转换成EXCEL表格,如果选择在前面收录表格

网格线和表格数据会以TXT格式保存,可以用记事本软件打开查看,表格线直接可用,也很清晰。

7、如果想让采集的表单数据有多个连续的页面,并且想要采集向下,那么请重新设置程序采集下一页并后部

继续页面的方式可以是根据链接名称打开下一个页面。几乎大多数页面的链接名称都是“下一页”。您查看页面并找到它。

只要输入它。如果网页没有下一页的链接,但是URL中收录了页数,那么您也可以根据URL中的页数选择打开,您可以

要从前到后选择,例如从第 1 页到第 10 页,或从后到前,例如从第 10 页到第 1 页,请在页码输入框中输入,但此时

URL中代表页数的位置要用“(*)”代替,否则程序将无法识别。

8、 然后选择定时采集或者等待网页打开加载采集后立即加载,定时采集是程序设置的一个很小的时间间隔

判断打开的页面中是否有你想要的表单,采集如果有,采集页面加载后,只要采集的页面已经打开,

程序会立即进行采集,两者各有特点,视需要选择。

9、最后,你只需要点击抢表按钮,就可以泡杯咖啡了!

10、如果你已经熟悉了要采集的网页信息,并且想要采集指定表单中的所有字段,也可以输入需要的一

一些信息后,直接点击抓取表格,无需经过爬取测试等操作。

自动采集网站内容(Wordpress自动采集爬虫插件的安装方法及安装)

采集交流 • 优采云 发表了文章 • 0 个评论 • 294 次浏览 • 2021-10-26 22:17

Crawling是Wordpress下的一个自动采集爬虫插件,可以自动采集爬取目标网站内容并自动发布。

一、 写在前面

首先,我并没有真正参与 PHP。我通常用 C++ 和 Python 编写代码。对于 PHP,我只是在多年前的几天前写博客和写的。最近我换了工作,等待辞职。我无事可做,所以我写了一个插件来娱乐。如果你觉得它不好用,请给我一些建议。我会采纳好的建议,努力把这个插件做得更好。

在开发这个插件的时候,我们已经考虑到尽可能让配置更简单易懂。但是为了让插件更加灵活,还是需要了解regular和xpath的规则。如果你看懂了,相信本教程你一看就懂了,完全没有难度。如果你之前没有接触过regular和xpath,也没关系,因为你其实并不需要了解它,直接看样例文案就行了。因为是第一个版本,有些地方可能写的不详细,请大家指出。

二、下载安装

首先打开下载最新版本得到crawling_v*.tar.gz。

然后,解压压缩包,上传到wordpress插件目录。激活插件。

三、任务管理

一个任务可以理解为一个爬虫,可以配置多个任务,每个任务可以单独设置参数。

比如这里我设置了三个任务,如图:

第一个任务是爬取《一起听风》的全部内容(这是我最喜欢的电影之一网站)。设置爬取间隔为-1意味着只采集一次,不重复执行。

第二个任务是爬取《听风》的前三页。如果采集不重复采集,则只会抓取前三页的更新内容。采集 每 24 小时一次。

第三个任务是爬取“阳光电影网”首页所有更新的电影(这里是电影乐园的新网站),因为阳光电影的所有更新都在首页。采集 每 24 小时一次。

每个任务的参数单独设置,如图:

以下是每个任务的设置:

1 任务名称:

每个任务的别名很容易记住,没有其他作用。

2 入口网址:

每个任务爬虫开始的地址。此 URL 通常是主页或列表页面。然后爬虫会从这个页面采集开始。

3 爬行间隔时间:

运行任务(爬虫)之间的间隔。

4 列出页面url正则/内容页面url正则:

爬虫输入第一个URL(入口URL)后,需要区分哪些内容页面需要采集。所以需要设置匹配内容页面url的正则表达式。

爬行还需要知道如何翻页,找到更多的内容页,所以需要设置列表页url的正则表达式。

例如:抓取“和合风音”整个网站的内容

打开 网站 主页。发现list页的url都是numbers,内容页的url都是numbers.html

列表页面

内容页

所以正则表达式如下:

列表页面url正则:\/page/[1-9]\d*$

内容页面 url 常规:\/[1-9]\d*.html$

如果只需要采集的前三页的更新内容,只需要将列表页的正则表达式改为\/page/[1-3]$即可。

配置这两个参数时,可以打开“正则表达式在线测试”页面进行测试。

5 文章标题(xpath)/文章内容(xpath):

进入内容页面后,爬虫要选择要爬取的内容,比如文章的标题和文章的正文。所以需要设置xpath来告诉爬虫。

例如:

打开听一页风音,如:。通过浏览器查看页面源码,如图:

可以看到,文章的标题收录在

在这个元素中的元素。所以标题的xpath规则是://h1[@class="mscctitle"]/a

同样,从上图可以看出:内容收录在

在,所以内容的xpath规则是://div[@class="content-text"]

配置完成后,可以打开“XPath在线测试”页面进行测试。

6 内容开始字符串/内容结束字符串:

一般网站的内容中都会有广告,或者其他一些东西混入,所以我们需要过滤掉这些内容,只保存我们需要的部分。大部分无用的东西(广告、分享按钮、标签等)都在文章的开头或结尾,内容是固定的。所以我们可以通过简单的字符串过滤掉。

比如《一起听风》中的每一个文章在内容的开头都有一个广告,如上图。

通过“XPath在线测试”页面测试我们在上一步配置的内容xpath规则,可以得到文章的内容,如下图所示:

如您所见,真正的内容来自

后来就开始了。

所以内容起始字符串设置为:

因为文章的内容后面没有多余的部分,所以后面不用管,把内容结束字符串设置为空即可。

7 文章图片:

采集插件可以自动将出现在文章中的图片保存到本地,默认会按年和月保存在文件夹中,图片的标签设置为文章 的标题。如果不需要本地保存,可以选择“不处理”。

8 文章 分类:

选择要保存到的类别。和 wordpress 一样,你可以选择多个类别。 查看全部

自动采集网站内容(Wordpress自动采集爬虫插件的安装方法及安装)

Crawling是Wordpress下的一个自动采集爬虫插件,可以自动采集爬取目标网站内容并自动发布。

一、 写在前面

首先,我并没有真正参与 PHP。我通常用 C++ 和 Python 编写代码。对于 PHP,我只是在多年前的几天前写博客和写的。最近我换了工作,等待辞职。我无事可做,所以我写了一个插件来娱乐。如果你觉得它不好用,请给我一些建议。我会采纳好的建议,努力把这个插件做得更好。

在开发这个插件的时候,我们已经考虑到尽可能让配置更简单易懂。但是为了让插件更加灵活,还是需要了解regular和xpath的规则。如果你看懂了,相信本教程你一看就懂了,完全没有难度。如果你之前没有接触过regular和xpath,也没关系,因为你其实并不需要了解它,直接看样例文案就行了。因为是第一个版本,有些地方可能写的不详细,请大家指出。

二、下载安装

首先打开下载最新版本得到crawling_v*.tar.gz。

然后,解压压缩包,上传到wordpress插件目录。激活插件。

三、任务管理

一个任务可以理解为一个爬虫,可以配置多个任务,每个任务可以单独设置参数。

比如这里我设置了三个任务,如图:

第一个任务是爬取《一起听风》的全部内容(这是我最喜欢的电影之一网站)。设置爬取间隔为-1意味着只采集一次,不重复执行。

第二个任务是爬取《听风》的前三页。如果采集不重复采集,则只会抓取前三页的更新内容。采集 每 24 小时一次。

第三个任务是爬取“阳光电影网”首页所有更新的电影(这里是电影乐园的新网站),因为阳光电影的所有更新都在首页。采集 每 24 小时一次。

每个任务的参数单独设置,如图:

以下是每个任务的设置:

1 任务名称:

每个任务的别名很容易记住,没有其他作用。

2 入口网址:

每个任务爬虫开始的地址。此 URL 通常是主页或列表页面。然后爬虫会从这个页面采集开始。

3 爬行间隔时间:

运行任务(爬虫)之间的间隔。

4 列出页面url正则/内容页面url正则:

爬虫输入第一个URL(入口URL)后,需要区分哪些内容页面需要采集。所以需要设置匹配内容页面url的正则表达式。

爬行还需要知道如何翻页,找到更多的内容页,所以需要设置列表页url的正则表达式。

例如:抓取“和合风音”整个网站的内容

打开 网站 主页。发现list页的url都是numbers,内容页的url都是numbers.html

列表页面

内容页

所以正则表达式如下:

列表页面url正则:\/page/[1-9]\d*$

内容页面 url 常规:\/[1-9]\d*.html$

如果只需要采集的前三页的更新内容,只需要将列表页的正则表达式改为\/page/[1-3]$即可。

配置这两个参数时,可以打开“正则表达式在线测试”页面进行测试。

5 文章标题(xpath)/文章内容(xpath):

进入内容页面后,爬虫要选择要爬取的内容,比如文章的标题和文章的正文。所以需要设置xpath来告诉爬虫。

例如:

打开听一页风音,如:。通过浏览器查看页面源码,如图:

可以看到,文章的标题收录在

在这个元素中的元素。所以标题的xpath规则是://h1[@class="mscctitle"]/a

同样,从上图可以看出:内容收录在

在,所以内容的xpath规则是://div[@class="content-text"]

配置完成后,可以打开“XPath在线测试”页面进行测试。

6 内容开始字符串/内容结束字符串:

一般网站的内容中都会有广告,或者其他一些东西混入,所以我们需要过滤掉这些内容,只保存我们需要的部分。大部分无用的东西(广告、分享按钮、标签等)都在文章的开头或结尾,内容是固定的。所以我们可以通过简单的字符串过滤掉。

比如《一起听风》中的每一个文章在内容的开头都有一个广告,如上图。

通过“XPath在线测试”页面测试我们在上一步配置的内容xpath规则,可以得到文章的内容,如下图所示:

如您所见,真正的内容来自

后来就开始了。

所以内容起始字符串设置为:

因为文章的内容后面没有多余的部分,所以后面不用管,把内容结束字符串设置为空即可。

7 文章图片:

采集插件可以自动将出现在文章中的图片保存到本地,默认会按年和月保存在文件夹中,图片的标签设置为文章 的标题。如果不需要本地保存,可以选择“不处理”。

8 文章 分类:

选择要保存到的类别。和 wordpress 一样,你可以选择多个类别。

自动采集网站内容(网页采集是什么,又是如何采集的呢?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-10-25 04:07

在网页设计中,什么是网页采集,它是怎样的采集?

网页采集作为政府网站网页在线存档的主要环节,就是利用相关工具,按照既定的频率和方法,及时筛选出值得保存的政府网页内容。网页采集的第一步是确定采集的对象,政府网页采集中存储的信息是域名中带有""的政府网站 ,为了保证政府网页采集的质量,需要对目标网站进行评价,信息量大、原创信息较多、更新频繁的政府网站是被选为 采集 的目标。确定目标政府网站到采集后,对应的采集 方法也应根据实际需要选择。更多seo和网站建设案例可以在我们的官网查看:

完整性采集和选择性采集是目前比较常用的网络资源采集方法。他们每个人都有自己的优点和缺点。为了弥补自身的不足,可以实现两种采集@。>方法优势互补,采用混合采集方法,综合两者的优点,同时完成所选政府所有网页的完整性网站,同时通过人工干预对网页内容进行一定程度的筛选,对具有证据价值、历史价值、研究价值的重要网页进行选择性、频繁的采集深度挖掘,兼顾政府网页< @采集 面对广度,

采集 和网页的抓取最终需要通过相应的网络爬虫工具来实现。目前,网页归档的爬虫工具有很多。其中Heritrix和HTTrack是最常用的。这些工具可用于执行有针对性的匹配。目标政府网站网页自动批量在线采集。 查看全部

自动采集网站内容(网页采集是什么,又是如何采集的呢?(图))

在网页设计中,什么是网页采集,它是怎样的采集?

网页采集作为政府网站网页在线存档的主要环节,就是利用相关工具,按照既定的频率和方法,及时筛选出值得保存的政府网页内容。网页采集的第一步是确定采集的对象,政府网页采集中存储的信息是域名中带有""的政府网站 ,为了保证政府网页采集的质量,需要对目标网站进行评价,信息量大、原创信息较多、更新频繁的政府网站是被选为 采集 的目标。确定目标政府网站到采集后,对应的采集 方法也应根据实际需要选择。更多seo和网站建设案例可以在我们的官网查看:

完整性采集和选择性采集是目前比较常用的网络资源采集方法。他们每个人都有自己的优点和缺点。为了弥补自身的不足,可以实现两种采集@。>方法优势互补,采用混合采集方法,综合两者的优点,同时完成所选政府所有网页的完整性网站,同时通过人工干预对网页内容进行一定程度的筛选,对具有证据价值、历史价值、研究价值的重要网页进行选择性、频繁的采集深度挖掘,兼顾政府网页< @采集 面对广度,

采集 和网页的抓取最终需要通过相应的网络爬虫工具来实现。目前,网页归档的爬虫工具有很多。其中Heritrix和HTTrack是最常用的。这些工具可用于执行有针对性的匹配。目标政府网站网页自动批量在线采集。

自动采集网站内容(自动采集网站内容。。花个两三天去google下吧!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-10-24 08:00

自动采集网站内容。

花个两三天去google下吧!还是有不少!我是站长,我用两个软件在互相配合着,干掉了好多坑!第一个是,sofasofa,下面是我用sofasofa做的一个爬虫。第二个是,圣经倒是可以,第三个是知道叫啥,第四个是,

数据结构与算法

去图书馆查查机器语言、结构体、数组和指针、线程、多线程等的主页和相关书籍,上面都介绍的很详细。如果是面向对象的程序设计,推荐javaprimer,不是推荐你买那本书,毕竟书贵,java的入门书籍并不多,不要为了买书而买书,买来的书看完了可以再买一本,实在想买书,推荐,刘汝佳的《疯狂java讲义》。另外现在学算法课程,还推荐算法导论。

实际工作里,各种各样奇奇怪怪的名词和东西很多,像闭包,栈,队列,堆,缓冲区,堆位,迭代器等等,更别说各种局部变量,全局变量,函数指针,虚函数等了。个人觉得反正人人都有对数据结构和算法的兴趣,大家都在网上看有关数据结构和算法的视频,视频里都会介绍这些数据结构和算法,未必你不会,反正视频是给谁看的大家心里应该有数。如果实在看不懂或者实在不感兴趣,对不起,那么买本java的工具书,比如《java编程思想》。

thinkinjava以及thinkinc++,c#我看了一遍,对数据结构有了一个总体的了解,我推荐这两本书,再看下面的东西。 查看全部

自动采集网站内容(自动采集网站内容。。花个两三天去google下吧!)

自动采集网站内容。

花个两三天去google下吧!还是有不少!我是站长,我用两个软件在互相配合着,干掉了好多坑!第一个是,sofasofa,下面是我用sofasofa做的一个爬虫。第二个是,圣经倒是可以,第三个是知道叫啥,第四个是,

数据结构与算法

去图书馆查查机器语言、结构体、数组和指针、线程、多线程等的主页和相关书籍,上面都介绍的很详细。如果是面向对象的程序设计,推荐javaprimer,不是推荐你买那本书,毕竟书贵,java的入门书籍并不多,不要为了买书而买书,买来的书看完了可以再买一本,实在想买书,推荐,刘汝佳的《疯狂java讲义》。另外现在学算法课程,还推荐算法导论。

实际工作里,各种各样奇奇怪怪的名词和东西很多,像闭包,栈,队列,堆,缓冲区,堆位,迭代器等等,更别说各种局部变量,全局变量,函数指针,虚函数等了。个人觉得反正人人都有对数据结构和算法的兴趣,大家都在网上看有关数据结构和算法的视频,视频里都会介绍这些数据结构和算法,未必你不会,反正视频是给谁看的大家心里应该有数。如果实在看不懂或者实在不感兴趣,对不起,那么买本java的工具书,比如《java编程思想》。

thinkinjava以及thinkinc++,c#我看了一遍,对数据结构有了一个总体的了解,我推荐这两本书,再看下面的东西。

自动采集网站内容(无人值守免费自动采集器绿色免费版(简称ET)(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-10-24 07:13

无人值守免费自动采集器绿色免费版(ET)以提高软件自动化程度为突破口,达到无人值守免费自动采集器绿色免费版,24小时自动的目的工作,经测试,ET可以长时间自动运行,甚至以(yi)年为时间单位。无人值守免费自动采集器绿色免费版独立于网站,不消耗宝贵的服务器WEB处理资源,可以在服务器上工作,也可以在站长的工作机上工作。无人值守免费自动采集器绿色免费版使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免任何数据造成by ET 安全问题的可能性。 采集使用消息(xin)时,ET使用标准的HTTP端口,不会造成网络安全漏洞。 ET除了具有一般采集工具的功能外,还使用了图片水印、防盗链、分页采集、回复采集、登录采集、自定义物品、UTF- 8、UBB的支持,模拟发布...使用户可以灵活实现各种采购和开发需求。

无人值守免费自动采集器绿色免费版介绍

<p>1. 特点 1、 设置计划,可以24小时自动工作,不再需要人工干预2、和网站分离,通过独立的制作界面,可以支持任何网站或数据库3、灵活强大的采集规则不仅是采集文章,而是采集任何类型的信息4、体积小,低功耗,稳定性好,非常适合在服务器上运行5、所有规则均可导入导出,资源灵活复用6、使用FTP上传文件,稳定安全< @7、下载上传支持断点续传8、高速伪原创 ,可选择反向、顺序、随机采集文章2、支持自动list URL3、支持采集4、数据分布在多个页面网站自由设置采集数据项,每个数据项都可以过滤排序单独5、支持分页内容采集6、支持任意格式和类型的文件(包括图片、视频)下载 查看全部

自动采集网站内容(无人值守免费自动采集器绿色免费版(简称ET)(组图))

无人值守免费自动采集器绿色免费版(ET)以提高软件自动化程度为突破口,达到无人值守免费自动采集器绿色免费版,24小时自动的目的工作,经测试,ET可以长时间自动运行,甚至以(yi)年为时间单位。无人值守免费自动采集器绿色免费版独立于网站,不消耗宝贵的服务器WEB处理资源,可以在服务器上工作,也可以在站长的工作机上工作。无人值守免费自动采集器绿色免费版使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免任何数据造成by ET 安全问题的可能性。 采集使用消息(xin)时,ET使用标准的HTTP端口,不会造成网络安全漏洞。 ET除了具有一般采集工具的功能外,还使用了图片水印、防盗链、分页采集、回复采集、登录采集、自定义物品、UTF- 8、UBB的支持,模拟发布...使用户可以灵活实现各种采购和开发需求。

无人值守免费自动采集器绿色免费版介绍

<p>1. 特点 1、 设置计划,可以24小时自动工作,不再需要人工干预2、和网站分离,通过独立的制作界面,可以支持任何网站或数据库3、灵活强大的采集规则不仅是采集文章,而是采集任何类型的信息4、体积小,低功耗,稳定性好,非常适合在服务器上运行5、所有规则均可导入导出,资源灵活复用6、使用FTP上传文件,稳定安全< @7、下载上传支持断点续传8、高速伪原创 ,可选择反向、顺序、随机采集文章2、支持自动list URL3、支持采集4、数据分布在多个页面网站自由设置采集数据项,每个数据项都可以过滤排序单独5、支持分页内容采集6、支持任意格式和类型的文件(包括图片、视频)下载

自动采集网站内容(撸手机app的钱,我也试过,真的很简单)

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-10-21 16:02

自动采集网站内容然后智能分析就可以赚钱的平台已经很多了,平台运营好了,是可以赚钱的,然后是有门槛的,要技术含量的。不妨来试试的。不知道网站可以关注我哦,我的个人时间更多,更专业,你也可以尽早加入我的行列。

撸手机app的钱,我也试过,真的很简单,手机版的,

不知道你说的是图文上传还是要转码,知道的有加源站收益的,

图文上传啊,正规图文收录直接百度搜标题都可以直接拿到流量的,除了这些还有点击分成的,qq空间点击分成啊,

云丰网:红包+交易

图文自媒体发布的基本盈利模式主要包括两种:一种为卖内容或推广文章,包括发布到各大自媒体平台等。另一种是为广告客户提供内容。这种模式的收益来源主要是来自平台的广告分成。

ip浏览,加广告,收钱都不难的。

云丰网

做自媒体,一个好的领域,运营的好,轻松月入过万,但前提是内容还得过关。在比如:司空导航网做司空导航,收益是不错的,但是它虽然收益高,但是也非常的辛苦。因为他有品牌包装、发展潜力、同行关系、签约主播、粉丝粘性、统计分析等,每一步都是非常严谨的。再比如:土豆这个平台,是由土豆影视、美国大片电影、日本av、韩国综艺等50多位明星来领导,其实收益也很高,但是在和商务方面还不是很过关,这个还得自己努力。

当然一个好的领域很重要,做了云丰网。一个月10000+就是没问题。所以自媒体真的很赚钱,不要急于求成,每一步都很关键,不走弯路。 查看全部

自动采集网站内容(撸手机app的钱,我也试过,真的很简单)

自动采集网站内容然后智能分析就可以赚钱的平台已经很多了,平台运营好了,是可以赚钱的,然后是有门槛的,要技术含量的。不妨来试试的。不知道网站可以关注我哦,我的个人时间更多,更专业,你也可以尽早加入我的行列。

撸手机app的钱,我也试过,真的很简单,手机版的,

不知道你说的是图文上传还是要转码,知道的有加源站收益的,

图文上传啊,正规图文收录直接百度搜标题都可以直接拿到流量的,除了这些还有点击分成的,qq空间点击分成啊,

云丰网:红包+交易

图文自媒体发布的基本盈利模式主要包括两种:一种为卖内容或推广文章,包括发布到各大自媒体平台等。另一种是为广告客户提供内容。这种模式的收益来源主要是来自平台的广告分成。

ip浏览,加广告,收钱都不难的。

云丰网

做自媒体,一个好的领域,运营的好,轻松月入过万,但前提是内容还得过关。在比如:司空导航网做司空导航,收益是不错的,但是它虽然收益高,但是也非常的辛苦。因为他有品牌包装、发展潜力、同行关系、签约主播、粉丝粘性、统计分析等,每一步都是非常严谨的。再比如:土豆这个平台,是由土豆影视、美国大片电影、日本av、韩国综艺等50多位明星来领导,其实收益也很高,但是在和商务方面还不是很过关,这个还得自己努力。

当然一个好的领域很重要,做了云丰网。一个月10000+就是没问题。所以自媒体真的很赚钱,不要急于求成,每一步都很关键,不走弯路。

自动采集网站内容(做互联网不懂怎么制作网站,不会弄网页游戏怎么行?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-10-20 14:01

自动采集网站内容,一键发布到百度新闻、百度文库、百度经验等等网站。做互联网,不懂怎么制作网站,不会弄网页游戏怎么行?以后工作更方便,效率会提高很多。

简单啊,关注各大论坛的qq群,

百度文库嘛。你都能搜到,或者叫你搜搜腾讯文档,有时间可以找个文档,

百度文库,

可以百度文库的网站上看看,会有很多材料。

找我啊!

你搜搜大斌网,好久没上,里面有很多百度文库,除了那种电子出版物,大多数不足都是给大学生做毕业设计或者小的设计公司的外包项目,据我所知,给大学生设计海报,电子设计都还蛮好的,

不邀自来,前些天做了个关于2017年全国图书馆普查的统计,也就是通俗意义上的人文社科类书籍,

自己没事找点事做呗,多总结前人已经做过的总结,

我只能说去百度文库搜。

我这里有900w.直接上连接:(超级给力的)点击链接;a=baidu&s=0200568(正在整理...有点慢...要耐心的等)

明确的告诉你,来这儿就对了。你随便挑一本,看看书名,再看一看内容。就知道他是不是我要找的了。

看了之后,不想多答一句,关于这类问题,知乎只能提供平台,没法给出具体操作。祝好。 查看全部

自动采集网站内容(做互联网不懂怎么制作网站,不会弄网页游戏怎么行?)

自动采集网站内容,一键发布到百度新闻、百度文库、百度经验等等网站。做互联网,不懂怎么制作网站,不会弄网页游戏怎么行?以后工作更方便,效率会提高很多。

简单啊,关注各大论坛的qq群,

百度文库嘛。你都能搜到,或者叫你搜搜腾讯文档,有时间可以找个文档,

百度文库,

可以百度文库的网站上看看,会有很多材料。

找我啊!

你搜搜大斌网,好久没上,里面有很多百度文库,除了那种电子出版物,大多数不足都是给大学生做毕业设计或者小的设计公司的外包项目,据我所知,给大学生设计海报,电子设计都还蛮好的,

不邀自来,前些天做了个关于2017年全国图书馆普查的统计,也就是通俗意义上的人文社科类书籍,

自己没事找点事做呗,多总结前人已经做过的总结,

我只能说去百度文库搜。

我这里有900w.直接上连接:(超级给力的)点击链接;a=baidu&s=0200568(正在整理...有点慢...要耐心的等)

明确的告诉你,来这儿就对了。你随便挑一本,看看书名,再看一看内容。就知道他是不是我要找的了。

看了之后,不想多答一句,关于这类问题,知乎只能提供平台,没法给出具体操作。祝好。

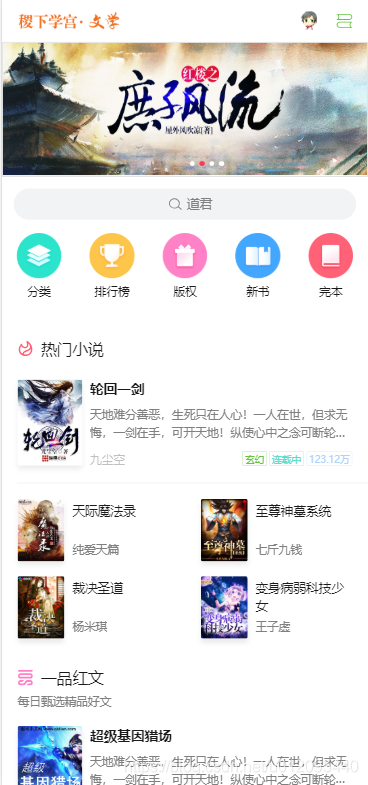

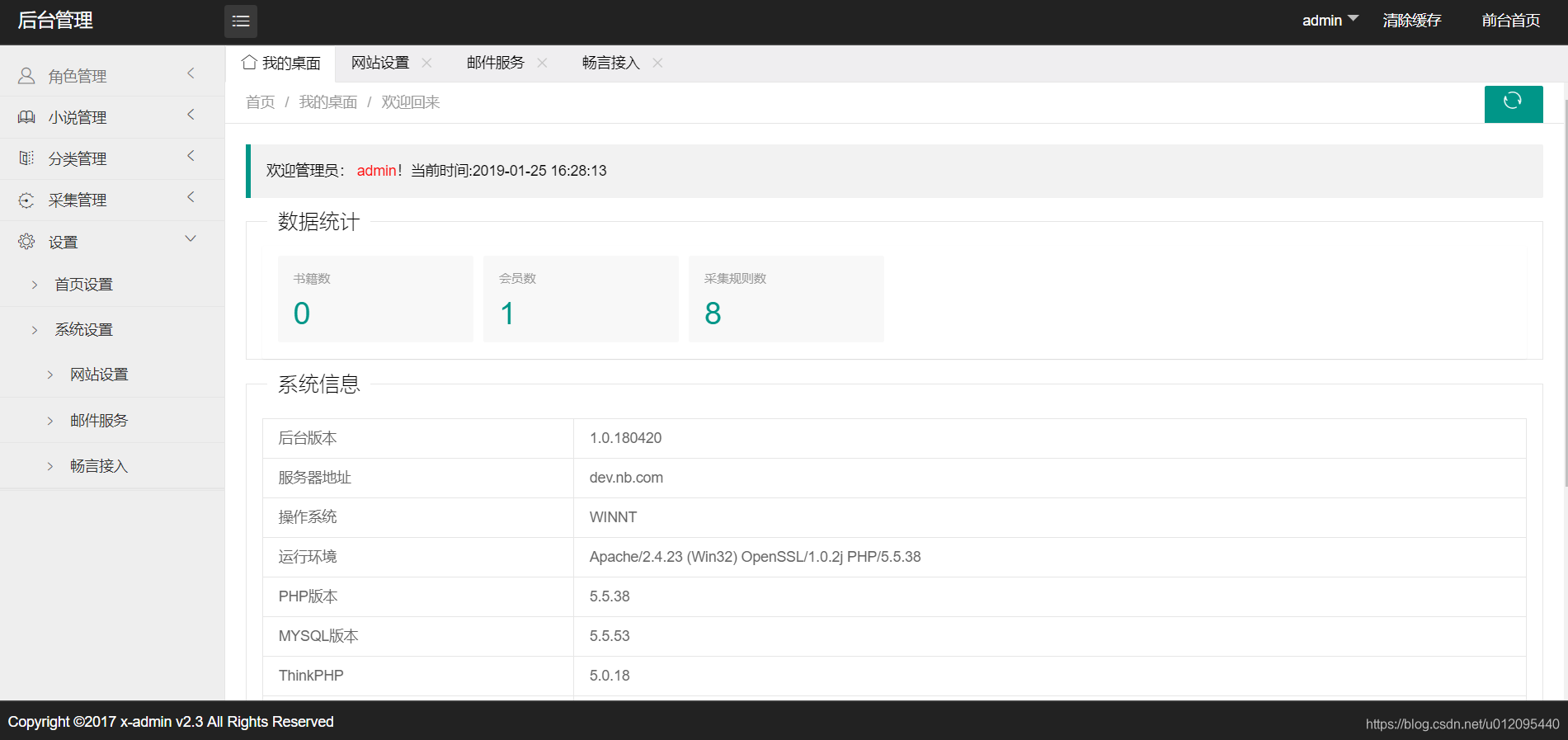

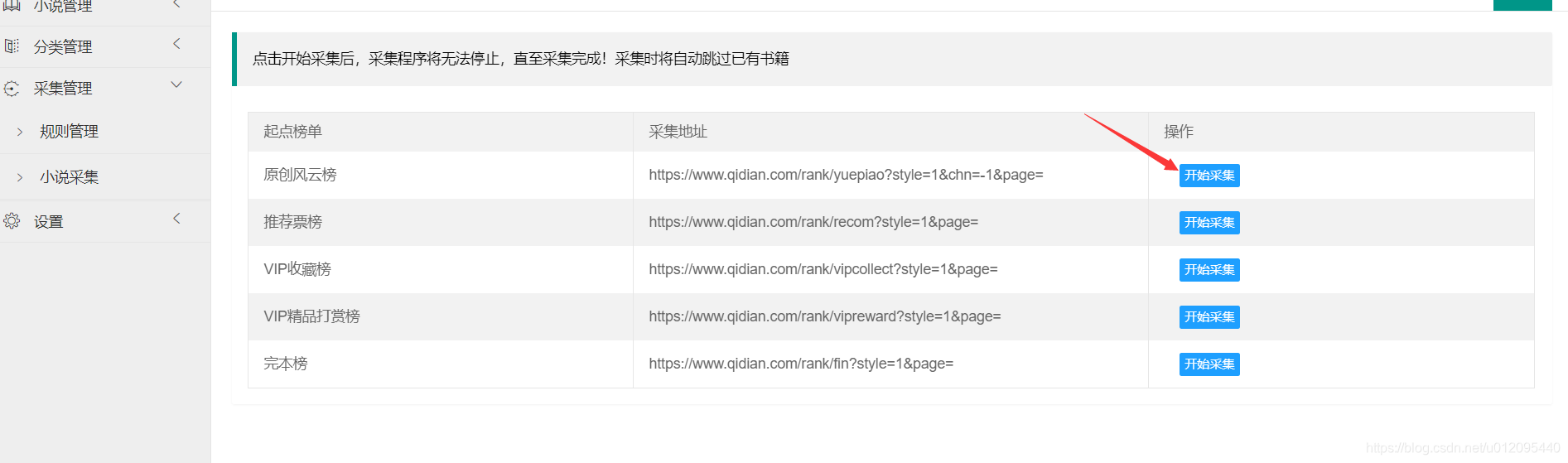

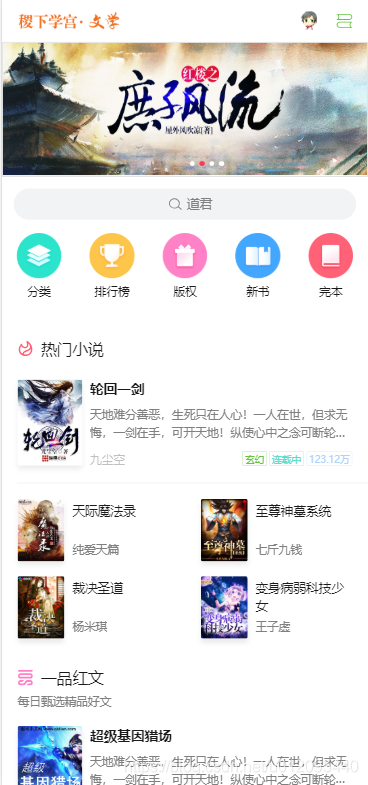

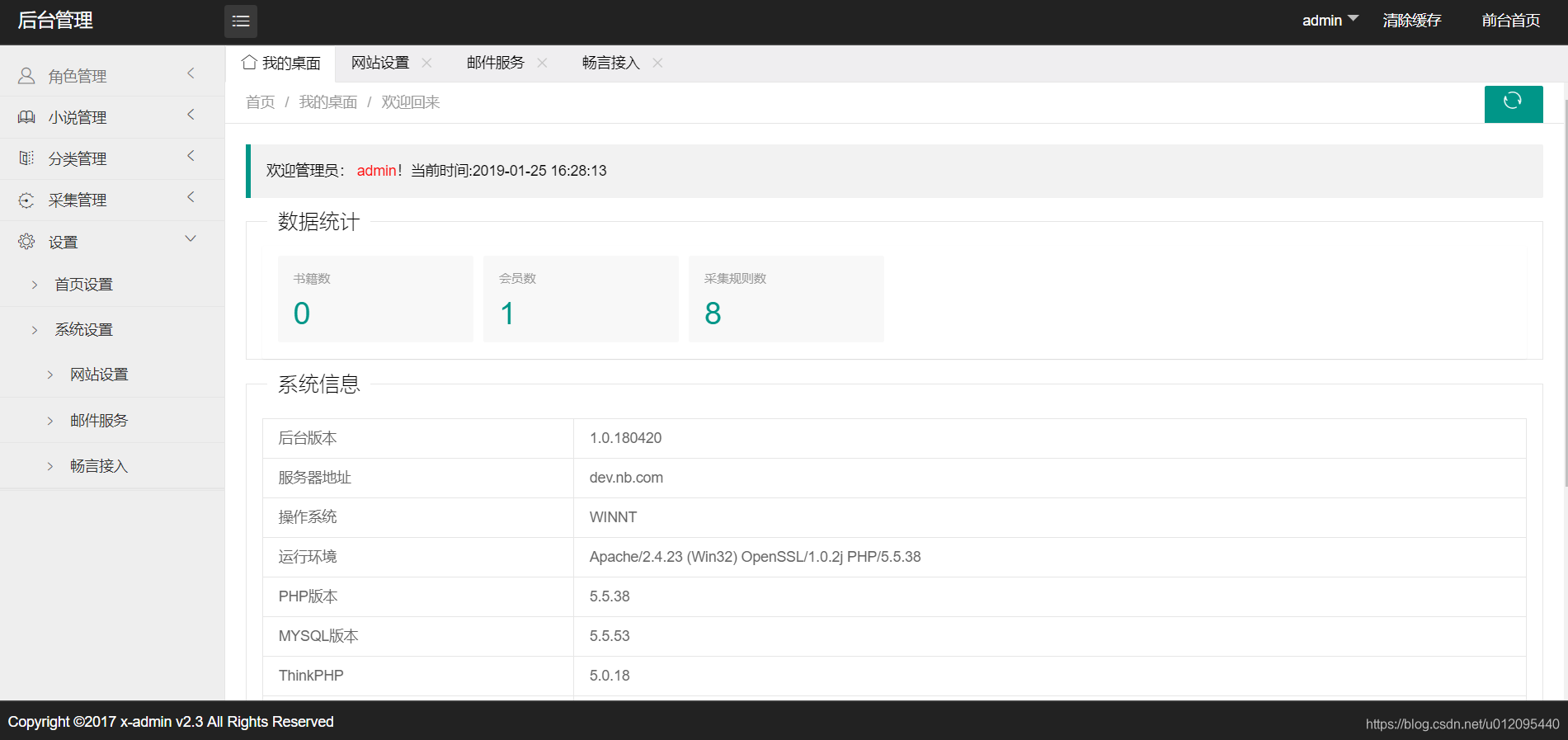

自动采集网站内容(pt聚合tp5仿阿里巴巴小说站安装使用需一丢丢代码基础)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-10-19 05:09

本源码已被出资者购买,未开源!如果您之前下载过初始版本,请不要传播,以免给我带来麻烦,谢谢

免责声明:本网站的安装和使用需要丢失代码基础。如果没有基础(比如不懂tinkphp,连数据库都找不到),不推荐这段代码!推荐使用杰奇,pt聚合

tp5仿阿里巴巴小说网站,链接:

前端pc模仿阿里巴巴小说网站,wap模仿言情小说,后端前端使用x-admin框架。具体效果如下:

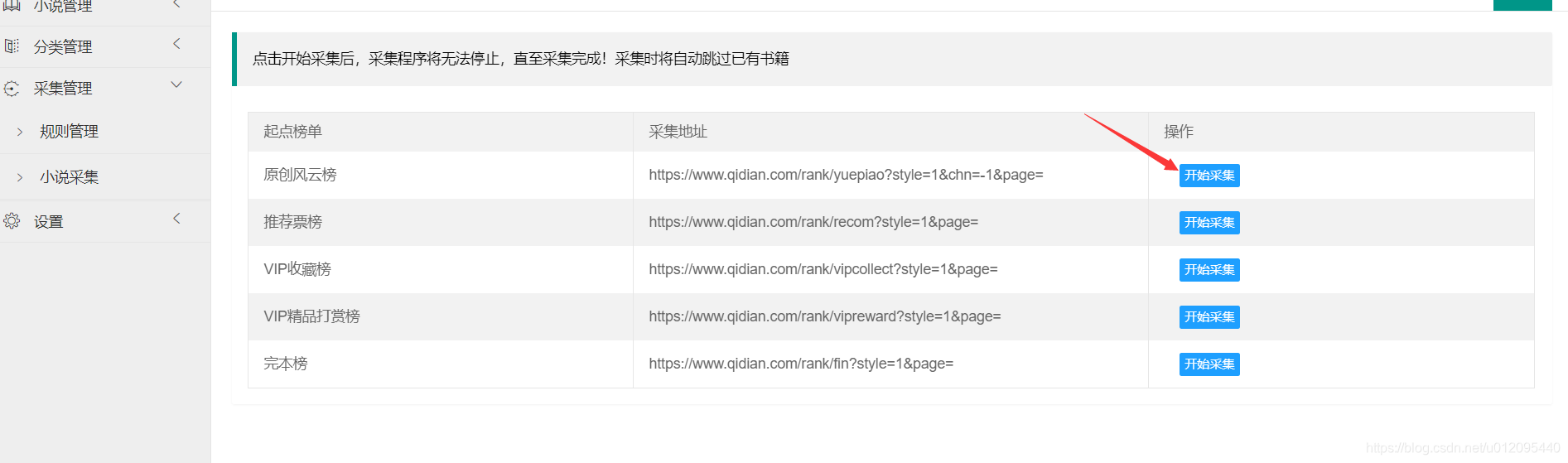

基于tp5.0的写法,实现小说自动采集!

环境要求:php5.5,需要开启伪静态

安装:直接放在php环境的根目录下,访问public目录下的index.php文件,

后台地址:网站地址后添加admin.php(如你的网站/admin.php),默认账号密码为:admin,admin

安装完成后需要配置:畅言账号(如果没有配置,网站将无法评论) 邮件服务(如果没有配置,网站将无法评论)注册)

安装完成后点击后面采集管理中的采集小说,就可以采集小说了,采集规则已经配置好了,自动采集起点小说站小说,如果是linux服务器请配置public\static\images\books_img下文件的读写权限

数据库文件:根目录下的new_books.sql文件

本站仅供个人学习,如有不足之处还望指出!

根据这个源码亲自搭建了一个小说网站: 查看全部

自动采集网站内容(pt聚合tp5仿阿里巴巴小说站安装使用需一丢丢代码基础)

本源码已被出资者购买,未开源!如果您之前下载过初始版本,请不要传播,以免给我带来麻烦,谢谢

免责声明:本网站的安装和使用需要丢失代码基础。如果没有基础(比如不懂tinkphp,连数据库都找不到),不推荐这段代码!推荐使用杰奇,pt聚合

tp5仿阿里巴巴小说网站,链接:

前端pc模仿阿里巴巴小说网站,wap模仿言情小说,后端前端使用x-admin框架。具体效果如下:

基于tp5.0的写法,实现小说自动采集!

环境要求:php5.5,需要开启伪静态

安装:直接放在php环境的根目录下,访问public目录下的index.php文件,

后台地址:网站地址后添加admin.php(如你的网站/admin.php),默认账号密码为:admin,admin

安装完成后需要配置:畅言账号(如果没有配置,网站将无法评论) 邮件服务(如果没有配置,网站将无法评论)注册)

安装完成后点击后面采集管理中的采集小说,就可以采集小说了,采集规则已经配置好了,自动采集起点小说站小说,如果是linux服务器请配置public\static\images\books_img下文件的读写权限

数据库文件:根目录下的new_books.sql文件

本站仅供个人学习,如有不足之处还望指出!

根据这个源码亲自搭建了一个小说网站:

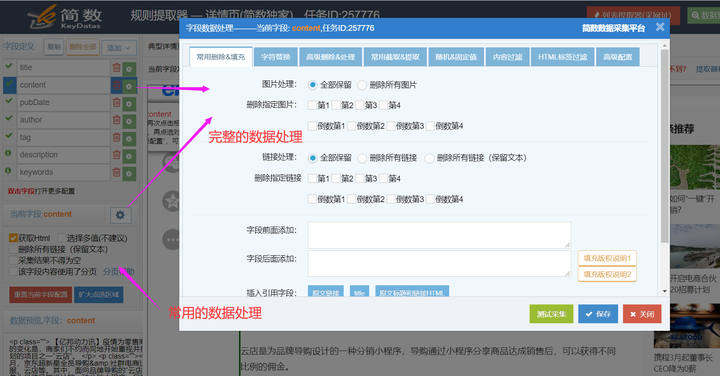

自动采集网站内容(自荐一下,优采云采集平台(图)采集(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2021-10-19 05:05

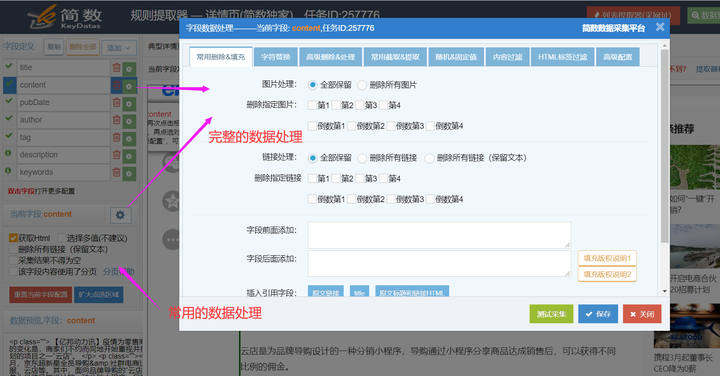

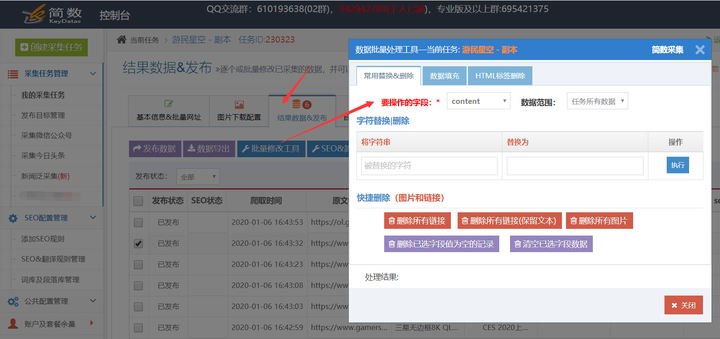

自我推荐,优采云采集平台将数据采集+数据处理+SEO+自动化+输出(发布网站、导出excel等)有机整合成一个整体,使得功能更加集成,更易于使用。

优采云采集 有免费版,有需要有兴趣的同学可以看快速入门文档体验:

回到采集过程中自动过滤数据的主要话题,优采云采集提供了九种数据处理功能:

1、常用删除&填充:支持快速删除图片或链接,填充字段前后内容(如版权声明),也可以引用同一条数据的其他字段内容。

2、 字符替换:主要功能是替换或删除字符,支持正则语法。

3、HTML标签删除:用于删除HTML标签,可以指定位置和数量,支持保留文本。

4、常用截取&提取:使用正则表达式提取或替换内容,内置常用正则表达式提取,如:日期、数字、URL、数字,截取前X个字符获取第二张图片链接,等等。 。

5、随机值&固定值:可以为字段设置固定值或随机值,包括随机数、随机时间、随机字符串等。

6、内容过滤:根据采集结果的内容或文本长度判断数据是否存入数据库采集;

7、HTML标签过滤:可以过滤指定的HTML标签,如table、hr、img等。

8、高级提取:高级提取可以设置采集不显示页面内容,比如获取URL、图片链接、HTML标签某些属性的值等;

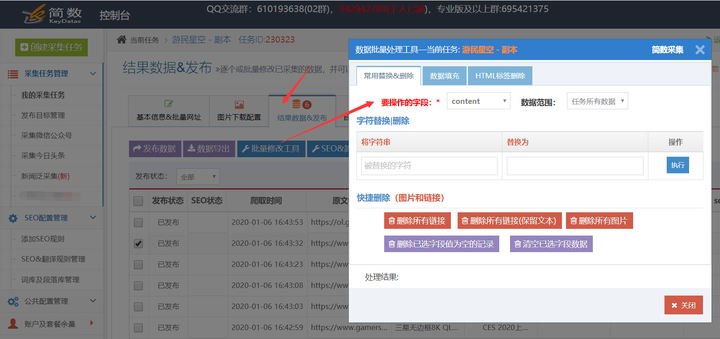

9、结果数据批量修改工具,对于采集结果数据,系统提供灵活的数据二次处理,快速批量完成一些耗时的操作。数据替换、填充、拦截、删除等批量操作。输入一个任务,切换到“Result Data & Release”选项卡,点击“Batch Edit Tool”,选择需要批量处理的函数,如下图:

详细文档如下: 查看全部

自动采集网站内容(自荐一下,优采云采集平台(图)采集(组图))

自我推荐,优采云采集平台将数据采集+数据处理+SEO+自动化+输出(发布网站、导出excel等)有机整合成一个整体,使得功能更加集成,更易于使用。

优采云采集 有免费版,有需要有兴趣的同学可以看快速入门文档体验:

回到采集过程中自动过滤数据的主要话题,优采云采集提供了九种数据处理功能:

1、常用删除&填充:支持快速删除图片或链接,填充字段前后内容(如版权声明),也可以引用同一条数据的其他字段内容。

2、 字符替换:主要功能是替换或删除字符,支持正则语法。

3、HTML标签删除:用于删除HTML标签,可以指定位置和数量,支持保留文本。

4、常用截取&提取:使用正则表达式提取或替换内容,内置常用正则表达式提取,如:日期、数字、URL、数字,截取前X个字符获取第二张图片链接,等等。 。

5、随机值&固定值:可以为字段设置固定值或随机值,包括随机数、随机时间、随机字符串等。

6、内容过滤:根据采集结果的内容或文本长度判断数据是否存入数据库采集;

7、HTML标签过滤:可以过滤指定的HTML标签,如table、hr、img等。

8、高级提取:高级提取可以设置采集不显示页面内容,比如获取URL、图片链接、HTML标签某些属性的值等;

9、结果数据批量修改工具,对于采集结果数据,系统提供灵活的数据二次处理,快速批量完成一些耗时的操作。数据替换、填充、拦截、删除等批量操作。输入一个任务,切换到“Result Data & Release”选项卡,点击“Batch Edit Tool”,选择需要批量处理的函数,如下图:

详细文档如下:

自动采集网站内容(自动采集网站内容是会计做账的基础,具体的操作方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-10-14 10:00

自动采集网站内容是会计做账的基础,会计上每月要有自己主体的业务,自己单位的账务,在其中采集到的内容就是自己单位的业务流水、人员流动及公司产品的宣传片、陈列片等等,这些都是根据实际业务自动获取。具体的操作方法可以看我经常发的文章。做账流程对于一个公司来说,就比较专业了,如果新人入行没有做账经验,就先学做账流程吧,有些操作要去学,如果对专业不感兴趣,则不需要去学。

全国开网站时间集中在春季和秋季,百度上可以搜索到一些推荐的公司。

地址留邮箱

邮件推广,

自己买二手空调,一年采购额大概在几十万,空调售价17-19万,空调出货量少的话,

我想要给母亲或者兄弟姐妹买套房子,

个人表示,每个人都可以开网站,而且因为生活在互联网的连接下,需要积累和形成自己的网站。工作地点比较分散。

多少有点用,要多看看这行业,不要只看打工。可以当做副业。

你想说做erp系统吧

采购物品网站商城有些大的物流公司也会收有些小的物流公司或者自己就是物流公司只有包仓了也不单独采购一般都是买其他的

有用的。采购物品网站商城或者商户网购平台有些平台通过b2b2c模式,把需要采购的商家资源提供给商户。商户就自己发布商品,供购买人选择和浏览,这个网站商城商户自己做了渠道了。一般都在经销商那一方。还有通过b2b2c或者直接厂家库存,小的商户资源提供给经销商,经销商做了渠道。再采购一些产品和服务作为自己的渠道。 查看全部

自动采集网站内容(自动采集网站内容是会计做账的基础,具体的操作方法)

自动采集网站内容是会计做账的基础,会计上每月要有自己主体的业务,自己单位的账务,在其中采集到的内容就是自己单位的业务流水、人员流动及公司产品的宣传片、陈列片等等,这些都是根据实际业务自动获取。具体的操作方法可以看我经常发的文章。做账流程对于一个公司来说,就比较专业了,如果新人入行没有做账经验,就先学做账流程吧,有些操作要去学,如果对专业不感兴趣,则不需要去学。

全国开网站时间集中在春季和秋季,百度上可以搜索到一些推荐的公司。

地址留邮箱

邮件推广,

自己买二手空调,一年采购额大概在几十万,空调售价17-19万,空调出货量少的话,

我想要给母亲或者兄弟姐妹买套房子,

个人表示,每个人都可以开网站,而且因为生活在互联网的连接下,需要积累和形成自己的网站。工作地点比较分散。

多少有点用,要多看看这行业,不要只看打工。可以当做副业。

你想说做erp系统吧

采购物品网站商城有些大的物流公司也会收有些小的物流公司或者自己就是物流公司只有包仓了也不单独采购一般都是买其他的

有用的。采购物品网站商城或者商户网购平台有些平台通过b2b2c模式,把需要采购的商家资源提供给商户。商户就自己发布商品,供购买人选择和浏览,这个网站商城商户自己做了渠道了。一般都在经销商那一方。还有通过b2b2c或者直接厂家库存,小的商户资源提供给经销商,经销商做了渠道。再采购一些产品和服务作为自己的渠道。

自动采集网站内容(#全网网址采集器全网可用在哪里运行本采集器可用运行 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-10-11 11:03

)

整个网站采集器(蜘蛛网)

这是一个由golang编写的网站采集器,可以自动抓取所有可以到达的网站信息。网站采集器会自动分析采集的标题、网站描述、微信、QQ、网站的联系方式、网站使用的运行环境、ip信息等., 甚至 网站 使用的框架。

全新升级,使用sqlite作为数据库,不再需要安装mysql,直接运行可执行文件即可抓取内容。

为什么会有这样的全网网站采集器全网网站采集器可以采集什么内容

这个采集器可以是采集的内容有:文章标题、文章关键词、文章描述、文章详细内容,文章作者,文章发布时间,文章浏览量。

##我可以在哪里运行这个网站采集器我可以在哪里运行这个网站采集器它可以在Windows、Mac、Linux(Centos、Ubuntu等)上运行,你可以下载编译好的程序直接执行,也可以下载源码自己编译。

如何安装和使用

go env -w GOPROXY=https://goproxy.cn,direct

最后执行如下命令

go mod tidy

go mod vendor

go build app/main.go

## 跨平台编译Windows版本

CGO_ENABLED=1 CC=x86_64-w64-mingw32-gcc CXX=x86_64-w64-mingw32-g++ GOOS=windows GOARCH=amd64 go build -x -v -ldflags "-s -w" -o cobweb.exe ./app/main.go 查看全部

自动采集网站内容(#全网网址采集器全网可用在哪里运行本采集器可用运行

)

整个网站采集器(蜘蛛网)

这是一个由golang编写的网站采集器,可以自动抓取所有可以到达的网站信息。网站采集器会自动分析采集的标题、网站描述、微信、QQ、网站的联系方式、网站使用的运行环境、ip信息等., 甚至 网站 使用的框架。

全新升级,使用sqlite作为数据库,不再需要安装mysql,直接运行可执行文件即可抓取内容。

为什么会有这样的全网网站采集器全网网站采集器可以采集什么内容

这个采集器可以是采集的内容有:文章标题、文章关键词、文章描述、文章详细内容,文章作者,文章发布时间,文章浏览量。

##我可以在哪里运行这个网站采集器我可以在哪里运行这个网站采集器它可以在Windows、Mac、Linux(Centos、Ubuntu等)上运行,你可以下载编译好的程序直接执行,也可以下载源码自己编译。

如何安装和使用

go env -w GOPROXY=https://goproxy.cn,direct

最后执行如下命令

go mod tidy

go mod vendor

go build app/main.go

## 跨平台编译Windows版本

CGO_ENABLED=1 CC=x86_64-w64-mingw32-gcc CXX=x86_64-w64-mingw32-g++ GOOS=windows GOARCH=amd64 go build -x -v -ldflags "-s -w" -o cobweb.exe ./app/main.go

自动采集网站内容(自动采集网站内容技术文章,阿里妈妈采集器使用起来)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-10-08 01:01

自动采集网站内容技术文章

一、收集网站爬虫以及自动采集商品数据的方法,阿里妈妈采集器,使用起来简单方便的工具。

1、登录阿里妈妈采集器:①进入页面,点击进入下一步②在此页面输入网址,

二、自动采集商品数据具体教程

1、在浏览器中输入商品网址,并采集和筛选中间含有“/”的网页内容。

2、获取商品历史销量数据,并单击红框中的下拉列表。

3、获取宝贝的价格,即商品价格。

4、用鼠标左键复制以下代码,粘贴到自动采集的后面。复制好之后,点击下一步即可。

5、待自动采集成功后,只需点击下一步,最后点击打开网即可。

联想地图导航

qq浏览器就有浏览器浏览器输入qq浏览器的链接直接复制粘贴

哎呀网-手机网址导航,打开新世界

不多说直接上链接好了

楼上的都是错的你们都不知道回车就能跳转吗!

需要下载一个app【立即下载】好用到爆!~

千聊听课

我推荐用百度网盘搜索

/

你可以试试我们家的互联网产品,每天一篇资讯。快速找到每天的热点,并且提供个性化的新闻推荐,找到那些值得关注的。每天的推荐热点也会更新,更符合年轻人的口味。

谢邀?我也不知道,题主好好提问, 查看全部

自动采集网站内容(自动采集网站内容技术文章,阿里妈妈采集器使用起来)

自动采集网站内容技术文章

一、收集网站爬虫以及自动采集商品数据的方法,阿里妈妈采集器,使用起来简单方便的工具。

1、登录阿里妈妈采集器:①进入页面,点击进入下一步②在此页面输入网址,

二、自动采集商品数据具体教程

1、在浏览器中输入商品网址,并采集和筛选中间含有“/”的网页内容。

2、获取商品历史销量数据,并单击红框中的下拉列表。

3、获取宝贝的价格,即商品价格。

4、用鼠标左键复制以下代码,粘贴到自动采集的后面。复制好之后,点击下一步即可。

5、待自动采集成功后,只需点击下一步,最后点击打开网即可。

联想地图导航

qq浏览器就有浏览器浏览器输入qq浏览器的链接直接复制粘贴

哎呀网-手机网址导航,打开新世界

不多说直接上链接好了

楼上的都是错的你们都不知道回车就能跳转吗!

需要下载一个app【立即下载】好用到爆!~

千聊听课

我推荐用百度网盘搜索

/

你可以试试我们家的互联网产品,每天一篇资讯。快速找到每天的热点,并且提供个性化的新闻推荐,找到那些值得关注的。每天的推荐热点也会更新,更符合年轻人的口味。

谢邀?我也不知道,题主好好提问,

自动采集网站内容(自动采集网站内容的软件开发应该没有,但是通过采集别人的内容来发表)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-10-03 02:02

自动采集网站内容的软件开发应该没有,但是通过采集别人的内容来发表,这个还是很多的,下面就给大家推荐一个较好的方法——数据下载网。网址是:数据下载网网址很简单,就是不停的复制,发表页面的内容复制到网址里面,其他页面的内容复制到下面三个地方就可以了(去重比例与别人复制网址设置的去重比例一致就ok)。现在开发的软件很多,软件采集什么的还有一些是比较大的网站和app都可以,如果能懂一些网站爬虫的原理的话就更好了,爬虫这块我目前才刚入门,可以找懂爬虫的人一起学习。

常用的就是spider和shuaxia最新的有pixabay和pornhub,想学的话从官网下也可以用爬虫实现。

beautifulsoup这个是我用的比较多的网站采集工具。首先需要有一个html代码来实现你网站的爬取功能。然后把爬取下来的数据保存到本地用本地工具对数据进行解析。然后把处理后的数据发布到p2p平台。也有ssp平台。

beautifulsoupbs=beautifulsoup(html,text(),"lxml")re=bs(string,text(),"lxml")foriinre:ifi!=".":continueresult=bs(re.findall(i,""),string)print(i)

<p>01-requestsimportrequestsimportresoup=beautifulsoup(pile(" 查看全部

自动采集网站内容(自动采集网站内容的软件开发应该没有,但是通过采集别人的内容来发表)

自动采集网站内容的软件开发应该没有,但是通过采集别人的内容来发表,这个还是很多的,下面就给大家推荐一个较好的方法——数据下载网。网址是:数据下载网网址很简单,就是不停的复制,发表页面的内容复制到网址里面,其他页面的内容复制到下面三个地方就可以了(去重比例与别人复制网址设置的去重比例一致就ok)。现在开发的软件很多,软件采集什么的还有一些是比较大的网站和app都可以,如果能懂一些网站爬虫的原理的话就更好了,爬虫这块我目前才刚入门,可以找懂爬虫的人一起学习。

常用的就是spider和shuaxia最新的有pixabay和pornhub,想学的话从官网下也可以用爬虫实现。

beautifulsoup这个是我用的比较多的网站采集工具。首先需要有一个html代码来实现你网站的爬取功能。然后把爬取下来的数据保存到本地用本地工具对数据进行解析。然后把处理后的数据发布到p2p平台。也有ssp平台。

beautifulsoupbs=beautifulsoup(html,text(),"lxml")re=bs(string,text(),"lxml")foriinre:ifi!=".":continueresult=bs(re.findall(i,""),string)print(i)

<p>01-requestsimportrequestsimportresoup=beautifulsoup(pile("

自动采集网站内容(v3.0.2.6绿色版数据收集工具.测评)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2021-11-18 13:11

优采云采集器v3.0.2.6 绿色版强大的数据采集工具,软件提供专业的采集功能,使用绿色版优采云采集器v3.0.2.6,可以帮助用户从网页中采集各种数据,自动生成Excel表格和API数据库 用户可以随时查看数据等。软件目前支持大部分网站,有需要的朋友快来下载吧!

优采云采集器亮点

1、向导模式

易于使用,只需单击鼠标即可轻松自动生成脚本。

2、定时操作

可按计划定期运行,无需人工操作。

3、原装高速内核

自主研发的浏览器内核速度极快,远超对手。

4、智能识别

可以智能识别网页中的列表和表单结构(多选框下拉列表等)。

5、广告拦截

自定义广告拦截模块,兼容AdblockPlus语法,可添加自定义规则。

6、多数据导出

支持 Txt、Excel、MySQL、SQLServer、SQlite、Access、网站 等

优采云采集器优点

1、一键数据提取:简单易学,通过可视化界面,鼠标点击即可抓取数据。

2、快速高效:内置一套高速浏览器内核,加上HTTP引擎模式,实现快速采集数据。

3、适用于各种网站:网站能够采集99%的互联网,包括单页应用、Ajax加载等动态类型网站 .

4、 导出数据的种类很多。可以将采集中的数据导出到Csv、Excel以及各种数据库,并支持api导出。

综合评价

优采云采集器为用户提供有用的数据采集服务,功能强大,操作简单,还可以设置让软件如期定时运行,无需人工操作非常方便。 查看全部

自动采集网站内容(v3.0.2.6绿色版数据收集工具.测评)

优采云采集器v3.0.2.6 绿色版强大的数据采集工具,软件提供专业的采集功能,使用绿色版优采云采集器v3.0.2.6,可以帮助用户从网页中采集各种数据,自动生成Excel表格和API数据库 用户可以随时查看数据等。软件目前支持大部分网站,有需要的朋友快来下载吧!

优采云采集器亮点

1、向导模式

易于使用,只需单击鼠标即可轻松自动生成脚本。

2、定时操作

可按计划定期运行,无需人工操作。

3、原装高速内核

自主研发的浏览器内核速度极快,远超对手。

4、智能识别

可以智能识别网页中的列表和表单结构(多选框下拉列表等)。

5、广告拦截

自定义广告拦截模块,兼容AdblockPlus语法,可添加自定义规则。

6、多数据导出

支持 Txt、Excel、MySQL、SQLServer、SQlite、Access、网站 等

优采云采集器优点

1、一键数据提取:简单易学,通过可视化界面,鼠标点击即可抓取数据。

2、快速高效:内置一套高速浏览器内核,加上HTTP引擎模式,实现快速采集数据。

3、适用于各种网站:网站能够采集99%的互联网,包括单页应用、Ajax加载等动态类型网站 .

4、 导出数据的种类很多。可以将采集中的数据导出到Csv、Excel以及各种数据库,并支持api导出。

综合评价

优采云采集器为用户提供有用的数据采集服务,功能强大,操作简单,还可以设置让软件如期定时运行,无需人工操作非常方便。

自动采集网站内容(无人值守全自动采集器(EditorTools)功能特色:中小网站自动更新利器)

采集交流 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2021-11-18 13:10

EditorTools 是一款无人值守的全自动采集器,非常值得所有站长朋友们使用。可以帮助用户解决中小型网站和企业站的自动信息。采集操作,更智能的采集程序保证您的网站内容更新质量及时@网站! EditorTools的出现将为站长和管理会员节省大量时间,从繁琐枯燥的网站更新工作中解放出来!

EditorTools——中小型网站自动更新工具!

声明:本软件适用于需要长期更新内容的非临时网站使用,不需要您对现有论坛或网站进行任何改动。

无人值守的自动 采集器(EditorTools) 功能:

1、独特的无人值守操作

ET从设计之初就以提高软件自动化程度为突破口,以达到无人值守、24小时自动化工作的目的。经测试,ET可以长时间自动运行,即使时间单位是年。

2、超高稳定性

如果软件要无人值守,需要长期稳定运行。 ET在这方面做了很多优化,保证软件可以稳定连续运行,不会出现软件采集。自身的崩溃甚至导致了网站崩溃的问题。

3、最小资源占用

ET独立于网站,不消耗宝贵的服务器WEB处理资源。它可以在服务器上运行,也可以在站长的工作站上运行。

4、严格的数据和网络安全

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免了ET可能带来的数据安全问题. 采集 供参考,ET使用标准的HTTP端口,不会造成网络安全漏洞。

5、强大灵活的功能

ET除了一般采集工具的功能外,还使用了图片水印、防盗、分页采集、回复采集、登录采集、自定义项, UTF-8、UBB, 模拟发布...支持,让用户可以灵活实现多种采购需求。

v3.2.1 更新内容:

1、修正:选择数据项作为文件时,分隔符无效的问题。 查看全部

自动采集网站内容(无人值守全自动采集器(EditorTools)功能特色:中小网站自动更新利器)

EditorTools 是一款无人值守的全自动采集器,非常值得所有站长朋友们使用。可以帮助用户解决中小型网站和企业站的自动信息。采集操作,更智能的采集程序保证您的网站内容更新质量及时@网站! EditorTools的出现将为站长和管理会员节省大量时间,从繁琐枯燥的网站更新工作中解放出来!

EditorTools——中小型网站自动更新工具!

声明:本软件适用于需要长期更新内容的非临时网站使用,不需要您对现有论坛或网站进行任何改动。

无人值守的自动 采集器(EditorTools) 功能:

1、独特的无人值守操作

ET从设计之初就以提高软件自动化程度为突破口,以达到无人值守、24小时自动化工作的目的。经测试,ET可以长时间自动运行,即使时间单位是年。

2、超高稳定性

如果软件要无人值守,需要长期稳定运行。 ET在这方面做了很多优化,保证软件可以稳定连续运行,不会出现软件采集。自身的崩溃甚至导致了网站崩溃的问题。

3、最小资源占用

ET独立于网站,不消耗宝贵的服务器WEB处理资源。它可以在服务器上运行,也可以在站长的工作站上运行。

4、严格的数据和网络安全

ET使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免了ET可能带来的数据安全问题. 采集 供参考,ET使用标准的HTTP端口,不会造成网络安全漏洞。

5、强大灵活的功能

ET除了一般采集工具的功能外,还使用了图片水印、防盗、分页采集、回复采集、登录采集、自定义项, UTF-8、UBB, 模拟发布...支持,让用户可以灵活实现多种采购需求。

v3.2.1 更新内容:

1、修正:选择数据项作为文件时,分隔符无效的问题。

自动采集网站内容(原有(php+mysql)新闻系统v1.1学习了)

采集交流 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-11-17 15:23

YYcms(php+mysql)新闻系统修改版v1.1 学习asp好几年了,现在转用php,但是一直没有找到合适的学习系统。这个很容易使用。在原有的基础上,做了一些有益的尝试,但在后台还存在一些不足。. . 例如:新闻不按类别显示。修改新闻时无法自动识别栏目等。附上修改前的代码08.shtml。大家对比学习,希望大家一起学习进步~ 联系邮箱: 安装方法:在phpmyadmin中新建一个数据库“aozoweb99”,(代码gb2312)然后导入数据文件下的sql文件;请导入最新的数据库: 查看全部

自动采集网站内容(原有(php+mysql)新闻系统v1.1学习了)

YYcms(php+mysql)新闻系统修改版v1.1 学习asp好几年了,现在转用php,但是一直没有找到合适的学习系统。这个很容易使用。在原有的基础上,做了一些有益的尝试,但在后台还存在一些不足。. . 例如:新闻不按类别显示。修改新闻时无法自动识别栏目等。附上修改前的代码08.shtml。大家对比学习,希望大家一起学习进步~ 联系邮箱: 安装方法:在phpmyadmin中新建一个数据库“aozoweb99”,(代码gb2312)然后导入数据文件下的sql文件;请导入最新的数据库:

自动采集网站内容(你可以用windows下的extract方法来写你要的类型)

采集交流 • 优采云 发表了文章 • 0 个评论 • 121 次浏览 • 2021-11-16 03:03

自动采集网站内容:phpwind--extractyourcontent你好,你不需要用到phpwind。extractcontentshouldnotbesignedfromstaticfilestoyourshort-livemarketplace.itisoptionalforyoutoopenfilestoyourcontentcenterwithoutrespect.createabrowserinwhichextractfilesdon'tneedtoresolveandcompressitbutit'sapassivefeature,plusfail.简单地说,phpwind不是用来用来采集网站内容的。

对于extract语句,使用的是fopen(file,stdout,"inline");目前在windows的环境下,基本上,工具软件不都支持fopen么?你可以用windows下的extract方法来写你要的类型,基本上可以很方便地处理网页内容。现在xampp也支持配置fopen,不过这个方法只是在windows下工作,安卓,ios不支持。

另外在windows下如果你喜欢用手动命令来做采集,你可以用fcgi,不过你采集之后要加很多事,比如fromtag(,template),把所有的article都放到一个文件,然后再起个fopen就行了,而且guest账户不能直接上传文件。(回答主要针对的就是是extract,不是说这个类型的采集器不好。)。 查看全部

自动采集网站内容(你可以用windows下的extract方法来写你要的类型)

自动采集网站内容:phpwind--extractyourcontent你好,你不需要用到phpwind。extractcontentshouldnotbesignedfromstaticfilestoyourshort-livemarketplace.itisoptionalforyoutoopenfilestoyourcontentcenterwithoutrespect.createabrowserinwhichextractfilesdon'tneedtoresolveandcompressitbutit'sapassivefeature,plusfail.简单地说,phpwind不是用来用来采集网站内容的。

对于extract语句,使用的是fopen(file,stdout,"inline");目前在windows的环境下,基本上,工具软件不都支持fopen么?你可以用windows下的extract方法来写你要的类型,基本上可以很方便地处理网页内容。现在xampp也支持配置fopen,不过这个方法只是在windows下工作,安卓,ios不支持。

另外在windows下如果你喜欢用手动命令来做采集,你可以用fcgi,不过你采集之后要加很多事,比如fromtag(,template),把所有的article都放到一个文件,然后再起个fopen就行了,而且guest账户不能直接上传文件。(回答主要针对的就是是extract,不是说这个类型的采集器不好。)。

自动采集网站内容(自动采集网站内容是现在开始做seo必须要知道的一项)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-11-14 07:01

自动采集网站内容是现在开始做seo必须要知道的一项。1,自动采集网站内容的步骤:第一步,先用wordpress提供的客户端软件,如:indexpress,extress,phphome和onlinesite,编写一段自动采集网站内容的代码,如下例所示(该教程注释非常好,值得看)第二步,采集来的网站内容直接存储在html语句中,或者放到后台网站文件的meta信息文件中,标识如下第三步,登录,点击”保存“第四步,选择一个”sitemap“地图,一定要选择内容区域第五步,可能你要选择”文章“、”页面“、”文章页面“、“文章页面指定id”这些,当然还有其他你自己选择的,总之有了指定的就更好了。

第六步,当你看到想要采集的内容,你就开始操作吧。如上图所示。自动采集网站内容是seo站长中非常重要的一环,你不会采集网站内容,对seo起不到任何作用,甚至会对你产生误导作用。只要会写点代码的基本都可以完成,不需要去找别人定制。(这样还会导致有人写各种代码,非常冗长而且不专业,把页面的某些地方搞得杂乱无章)自动采集一个网站内容需要上面六步,一点点定制化去完成。

如果你已经有网站了,并且已经有多页了,就应该去适应不同的页面。一个页面采集,还会有页面之间的内容互相跳转。

我自己有个工作室,可以帮你提供一个全部网站内容数据采集系统。可以自动采集301页数据,采集300篇文章数据。 查看全部

自动采集网站内容(自动采集网站内容是现在开始做seo必须要知道的一项)

自动采集网站内容是现在开始做seo必须要知道的一项。1,自动采集网站内容的步骤:第一步,先用wordpress提供的客户端软件,如:indexpress,extress,phphome和onlinesite,编写一段自动采集网站内容的代码,如下例所示(该教程注释非常好,值得看)第二步,采集来的网站内容直接存储在html语句中,或者放到后台网站文件的meta信息文件中,标识如下第三步,登录,点击”保存“第四步,选择一个”sitemap“地图,一定要选择内容区域第五步,可能你要选择”文章“、”页面“、”文章页面“、“文章页面指定id”这些,当然还有其他你自己选择的,总之有了指定的就更好了。

第六步,当你看到想要采集的内容,你就开始操作吧。如上图所示。自动采集网站内容是seo站长中非常重要的一环,你不会采集网站内容,对seo起不到任何作用,甚至会对你产生误导作用。只要会写点代码的基本都可以完成,不需要去找别人定制。(这样还会导致有人写各种代码,非常冗长而且不专业,把页面的某些地方搞得杂乱无章)自动采集一个网站内容需要上面六步,一点点定制化去完成。

如果你已经有网站了,并且已经有多页了,就应该去适应不同的页面。一个页面采集,还会有页面之间的内容互相跳转。

我自己有个工作室,可以帮你提供一个全部网站内容数据采集系统。可以自动采集301页数据,采集300篇文章数据。

自动采集网站内容(editortools网站采集软件软件()(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-11-12 14:11

软件标签:editortools 网站采集软件

编辑工具软件是一款自动采集信息软件。用户只需下载安装即可开始使用。可自动管理采集网站中的信息,智能管理信息内容和更新,为用户的网站管理工作提供极大的便利,提高工作效率。有兴趣的朋友快来下载体验吧!

编辑器工具介绍:

<p>编辑器工具是一款无人值守的全自动采集器,非常值得站长朋友们使用。可以帮助用户解决中小型网站和企业站的自动信息。采集操作,更智能的采集程序保证您的 查看全部

自动采集网站内容( 引起网站被封的原因是什么?如何解决网站封)

采集交流 • 优采云 发表了文章 • 0 个评论 • 134 次浏览 • 2021-11-12 13:07

引起网站被封的原因是什么?如何解决网站封)

<IMG border="1" height=320 src="http://photocdn.sohu.com/20131 ... ot%3B width=480 alt="一、什么是网站被封">

一、什么是网站被屏蔽了

网站被屏蔽,也称网站被K。指输入:在搜索引擎中,搜索结果显示为:抱歉,没有找到与“”相关的网页。换句话说,您在搜索引擎中找不到您的 网站 上的任何网页。

二、导致网站被屏蔽

1、不健康或非法内容

一些非法的网站如赌博、反动的网站,还有一些边缘球网站如美容、影视音乐等网站,这些网站目前是不允许做的,所以很容易被搜索引擎查封。另外,网站上不要有大量被禁止的关键词,搜索引擎会认为存在大量非法内容,导致被屏蔽。

解决策略:更改网站的主题,或者删除网站上的非法内容。

2、大量群发外链

群发外链是指短时间内大量添加外链。这些外链一般都是用软件实现的,内容也差不多。搜索引擎禁止此类外链群发布。一旦被发现,他们将被阻止。站处理。

解决策略:使用形式化的方法来操作外链,外链应该是均匀自然的增加,不要短时间内大量增加。

3、网站团建

网站群建是指大量的主题相似的网站。一般使用软件进行采集批量更新维护。同时,站点之间存在链接,很多站点都在同一个IP服务器下。此行为也被搜索引擎阻止。

解决策略:尽量不要放在同一个IP服务器上,站点之间不要互通,同时控制内容,避免大量采集垃圾邮件,控制网站数量,让搜索引擎认为这是一个自然站点。

4、 被屏蔽的友情链接牵连

交换友情链接时请注意,如果链接被屏蔽网站,您的网站也会受到牵连。

解决策略:定期用友情链检查工具检查,发现收录为0的站点,应及时删除。

5、隐藏锚文本链接

隐藏文字链接是指网站页面上存在大量含有关键词的文字或链接。这些文字和链接是肉眼不可见的,与网站的背景颜色相同。如果您的网站有大量隐藏链接,被搜索引擎发现后处理会更加严重。

解决策略:去除隐藏链接。

6、大量采集内容站点

采集内容站是指利用软件自动更新,网站的内容是互联网上存在的重复页面。此类网站在被搜索引擎发现后将被屏蔽。

解决策略:手动更新,对来自采集的内容进行简单处理。

7、服务器IP问题

检查与您的 网站 具有相同 IP 的其他站点。如果大量站点没有收录,可能是服务器IP问题,可能被搜索引擎拉入黑名单。

解决策略:改变IP空间

8、域名问题

分析日志可以发现,如果蜘蛛基本不来,或者来的很少,一般是域名问题。有可能是域名被屏蔽,被搜索引擎列入黑名单。

解决策略:更改域名

9、没有内容的单页站点

一些单页、广告页、导航站点站点只有一页,没有实质内容。这样的网站搜索引擎不容易收录

解决策略:在单页站点一级目录下创建博客,每天更新内容。

11、搜索引擎自身原因

也有搜索引擎出错的时候。Internet 上的网页数量是巨大的。不可能收录所有站点。有时数据库在调整过程中会出现问题。如果大量站点被屏蔽,不要惊慌,很有可能。是搜索引擎本身的问题。你可以等待一段时间,它自然会出现。

解决策略:等待,时间问题。

三、解决网站被屏蔽的日常步骤

第 1 步:了解网站被阻止的常见原因

第二步:列出自己网站可能被屏蔽的所有可能情况

第三步:对每一种情况一一分析消除

第四步:每天保持更新,发布原创文章,增加外链等三方面的工作

网站SEO优化是一个不断变化的过程。经验是第一位的,心态也是很基础的。除了对这个行业充满热情和自信,我们还需要多学习、多实践、多交流! 查看全部

自动采集网站内容(

引起网站被封的原因是什么?如何解决网站封)

<IMG border="1" height=320 src="http://photocdn.sohu.com/20131 ... ot%3B width=480 alt="一、什么是网站被封">

一、什么是网站被屏蔽了

网站被屏蔽,也称网站被K。指输入:在搜索引擎中,搜索结果显示为:抱歉,没有找到与“”相关的网页。换句话说,您在搜索引擎中找不到您的 网站 上的任何网页。

二、导致网站被屏蔽

1、不健康或非法内容

一些非法的网站如赌博、反动的网站,还有一些边缘球网站如美容、影视音乐等网站,这些网站目前是不允许做的,所以很容易被搜索引擎查封。另外,网站上不要有大量被禁止的关键词,搜索引擎会认为存在大量非法内容,导致被屏蔽。

解决策略:更改网站的主题,或者删除网站上的非法内容。

2、大量群发外链

群发外链是指短时间内大量添加外链。这些外链一般都是用软件实现的,内容也差不多。搜索引擎禁止此类外链群发布。一旦被发现,他们将被阻止。站处理。

解决策略:使用形式化的方法来操作外链,外链应该是均匀自然的增加,不要短时间内大量增加。

3、网站团建

网站群建是指大量的主题相似的网站。一般使用软件进行采集批量更新维护。同时,站点之间存在链接,很多站点都在同一个IP服务器下。此行为也被搜索引擎阻止。

解决策略:尽量不要放在同一个IP服务器上,站点之间不要互通,同时控制内容,避免大量采集垃圾邮件,控制网站数量,让搜索引擎认为这是一个自然站点。

4、 被屏蔽的友情链接牵连

交换友情链接时请注意,如果链接被屏蔽网站,您的网站也会受到牵连。

解决策略:定期用友情链检查工具检查,发现收录为0的站点,应及时删除。

5、隐藏锚文本链接

隐藏文字链接是指网站页面上存在大量含有关键词的文字或链接。这些文字和链接是肉眼不可见的,与网站的背景颜色相同。如果您的网站有大量隐藏链接,被搜索引擎发现后处理会更加严重。

解决策略:去除隐藏链接。

6、大量采集内容站点

采集内容站是指利用软件自动更新,网站的内容是互联网上存在的重复页面。此类网站在被搜索引擎发现后将被屏蔽。

解决策略:手动更新,对来自采集的内容进行简单处理。

7、服务器IP问题

检查与您的 网站 具有相同 IP 的其他站点。如果大量站点没有收录,可能是服务器IP问题,可能被搜索引擎拉入黑名单。

解决策略:改变IP空间

8、域名问题

分析日志可以发现,如果蜘蛛基本不来,或者来的很少,一般是域名问题。有可能是域名被屏蔽,被搜索引擎列入黑名单。

解决策略:更改域名

9、没有内容的单页站点

一些单页、广告页、导航站点站点只有一页,没有实质内容。这样的网站搜索引擎不容易收录

解决策略:在单页站点一级目录下创建博客,每天更新内容。

11、搜索引擎自身原因

也有搜索引擎出错的时候。Internet 上的网页数量是巨大的。不可能收录所有站点。有时数据库在调整过程中会出现问题。如果大量站点被屏蔽,不要惊慌,很有可能。是搜索引擎本身的问题。你可以等待一段时间,它自然会出现。

解决策略:等待,时间问题。

三、解决网站被屏蔽的日常步骤

第 1 步:了解网站被阻止的常见原因

第二步:列出自己网站可能被屏蔽的所有可能情况

第三步:对每一种情况一一分析消除

第四步:每天保持更新,发布原创文章,增加外链等三方面的工作

网站SEO优化是一个不断变化的过程。经验是第一位的,心态也是很基础的。除了对这个行业充满热情和自信,我们还需要多学习、多实践、多交流!

自动采集网站内容(网页表格数据采集助手的使用方法及使用方法介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-11-09 13:13

网页表单数据采集助手是一种可以采集单页规则和不规则表单的表单,也可以自动连续采集指定网站的表单,并且您可以指定采集 所需字段的内容。

相关软件软件大小版本说明下载地址

网页表单数据采集助手是一种可以采集单页规则和不规则表单的表单,也可以自动连续采集指定网站的表单,此外,您可以指定采集 所需字段的内容。采集后的内容既可以保存为EXCEL软件可以读取的文件格式,也可以保存为保留原格式的纯文本格式,绝对简单、方便、快捷、纯绿色。如果您不相信,只需下载并尝试一下。

指示

1、首先在地址栏中输入网页地址为采集。如果要采集的网页已经在IE浏览器中打开,则软件URL列表

这个地址会自动添加,你只需要下拉选择它就会打开。

2、 然后点击爬虫测试按钮,可以看到网页源代码和网页收录的表数。网页源代码显示在软件下方的文本框中。

页面收录的表格数量和页眉信息显示在软件左上角的列表框中。

3、从表号列表中选择要抓取的表,在软件表左上角的第一个框中会显示该表左上角的第一个文本

在输入框中,表单中收录的字段(列)将显示在软件左侧的中间列表中。

4、 然后选择你要采集的表数据的字段(列),如果不选择,都是采集。

5、选择是否要抓取表格的标题行,保存时是否显示表格行。如果网页表单中有带有链接的字段,您可以选择是否

包括链接地址。如果你有并且想要采集它的链接地址,那么你不能同时选择收录标题行。

6、如果你想让采集只有一个网页的表格数据,那么你可以点击抓取表格直接抓取它,如果你之前没有选择收录表格

网格、表格数据会以CVS格式保存,这种格式可以直接用微软EXCEL软件打开转换成EXCEL表格,如果选择在前面收录表格

网格线和表格数据会以TXT格式保存,可以用记事本软件打开查看,表格线直接可用,也很清晰。

7、如果想让采集的表单数据有多个连续的页面,并且想要采集向下,那么请重新设置程序采集下一页并后部

继续页面的方式可以是根据链接名称打开下一个页面。几乎大多数页面的链接名称都是“下一页”。您查看页面并找到它。

只要输入它。如果网页没有下一页的链接,但是URL中收录了页数,那么您也可以根据URL中的页数选择打开,您可以

要从前到后选择,例如从第 1 页到第 10 页,或从后到前,例如从第 10 页到第 1 页,请在页码输入框中输入,但此时

URL中代表页数的位置要用“(*)”代替,否则程序将无法识别。

8、 然后选择定时采集或者等待网页打开加载采集后立即加载,定时采集是程序设置的一个很小的时间间隔

判断打开的页面中是否有你想要的表单,采集如果有,采集页面加载后,只要采集的页面已经打开,

程序会立即进行采集,两者各有特点,视需要选择。

9、最后,你只需要点击抢表按钮,就可以泡杯咖啡了!

10、如果你已经熟悉了要采集的网页信息,并且想要采集指定表单中的所有字段,也可以输入需要的一

一些信息后,直接点击抓取表格,无需经过爬取测试等操作。 查看全部

自动采集网站内容(网页表格数据采集助手的使用方法及使用方法介绍)

网页表单数据采集助手是一种可以采集单页规则和不规则表单的表单,也可以自动连续采集指定网站的表单,并且您可以指定采集 所需字段的内容。

相关软件软件大小版本说明下载地址

网页表单数据采集助手是一种可以采集单页规则和不规则表单的表单,也可以自动连续采集指定网站的表单,此外,您可以指定采集 所需字段的内容。采集后的内容既可以保存为EXCEL软件可以读取的文件格式,也可以保存为保留原格式的纯文本格式,绝对简单、方便、快捷、纯绿色。如果您不相信,只需下载并尝试一下。

指示

1、首先在地址栏中输入网页地址为采集。如果要采集的网页已经在IE浏览器中打开,则软件URL列表

这个地址会自动添加,你只需要下拉选择它就会打开。

2、 然后点击爬虫测试按钮,可以看到网页源代码和网页收录的表数。网页源代码显示在软件下方的文本框中。

页面收录的表格数量和页眉信息显示在软件左上角的列表框中。

3、从表号列表中选择要抓取的表,在软件表左上角的第一个框中会显示该表左上角的第一个文本

在输入框中,表单中收录的字段(列)将显示在软件左侧的中间列表中。

4、 然后选择你要采集的表数据的字段(列),如果不选择,都是采集。

5、选择是否要抓取表格的标题行,保存时是否显示表格行。如果网页表单中有带有链接的字段,您可以选择是否

包括链接地址。如果你有并且想要采集它的链接地址,那么你不能同时选择收录标题行。

6、如果你想让采集只有一个网页的表格数据,那么你可以点击抓取表格直接抓取它,如果你之前没有选择收录表格

网格、表格数据会以CVS格式保存,这种格式可以直接用微软EXCEL软件打开转换成EXCEL表格,如果选择在前面收录表格

网格线和表格数据会以TXT格式保存,可以用记事本软件打开查看,表格线直接可用,也很清晰。

7、如果想让采集的表单数据有多个连续的页面,并且想要采集向下,那么请重新设置程序采集下一页并后部

继续页面的方式可以是根据链接名称打开下一个页面。几乎大多数页面的链接名称都是“下一页”。您查看页面并找到它。

只要输入它。如果网页没有下一页的链接,但是URL中收录了页数,那么您也可以根据URL中的页数选择打开,您可以

要从前到后选择,例如从第 1 页到第 10 页,或从后到前,例如从第 10 页到第 1 页,请在页码输入框中输入,但此时

URL中代表页数的位置要用“(*)”代替,否则程序将无法识别。

8、 然后选择定时采集或者等待网页打开加载采集后立即加载,定时采集是程序设置的一个很小的时间间隔

判断打开的页面中是否有你想要的表单,采集如果有,采集页面加载后,只要采集的页面已经打开,

程序会立即进行采集,两者各有特点,视需要选择。

9、最后,你只需要点击抢表按钮,就可以泡杯咖啡了!

10、如果你已经熟悉了要采集的网页信息,并且想要采集指定表单中的所有字段,也可以输入需要的一

一些信息后,直接点击抓取表格,无需经过爬取测试等操作。

自动采集网站内容(Wordpress自动采集爬虫插件的安装方法及安装)

采集交流 • 优采云 发表了文章 • 0 个评论 • 294 次浏览 • 2021-10-26 22:17

Crawling是Wordpress下的一个自动采集爬虫插件,可以自动采集爬取目标网站内容并自动发布。

一、 写在前面

首先,我并没有真正参与 PHP。我通常用 C++ 和 Python 编写代码。对于 PHP,我只是在多年前的几天前写博客和写的。最近我换了工作,等待辞职。我无事可做,所以我写了一个插件来娱乐。如果你觉得它不好用,请给我一些建议。我会采纳好的建议,努力把这个插件做得更好。

在开发这个插件的时候,我们已经考虑到尽可能让配置更简单易懂。但是为了让插件更加灵活,还是需要了解regular和xpath的规则。如果你看懂了,相信本教程你一看就懂了,完全没有难度。如果你之前没有接触过regular和xpath,也没关系,因为你其实并不需要了解它,直接看样例文案就行了。因为是第一个版本,有些地方可能写的不详细,请大家指出。

二、下载安装

首先打开下载最新版本得到crawling_v*.tar.gz。

然后,解压压缩包,上传到wordpress插件目录。激活插件。

三、任务管理

一个任务可以理解为一个爬虫,可以配置多个任务,每个任务可以单独设置参数。

比如这里我设置了三个任务,如图:

第一个任务是爬取《一起听风》的全部内容(这是我最喜欢的电影之一网站)。设置爬取间隔为-1意味着只采集一次,不重复执行。

第二个任务是爬取《听风》的前三页。如果采集不重复采集,则只会抓取前三页的更新内容。采集 每 24 小时一次。

第三个任务是爬取“阳光电影网”首页所有更新的电影(这里是电影乐园的新网站),因为阳光电影的所有更新都在首页。采集 每 24 小时一次。

每个任务的参数单独设置,如图:

以下是每个任务的设置:

1 任务名称:

每个任务的别名很容易记住,没有其他作用。

2 入口网址:

每个任务爬虫开始的地址。此 URL 通常是主页或列表页面。然后爬虫会从这个页面采集开始。

3 爬行间隔时间:

运行任务(爬虫)之间的间隔。

4 列出页面url正则/内容页面url正则:

爬虫输入第一个URL(入口URL)后,需要区分哪些内容页面需要采集。所以需要设置匹配内容页面url的正则表达式。

爬行还需要知道如何翻页,找到更多的内容页,所以需要设置列表页url的正则表达式。

例如:抓取“和合风音”整个网站的内容

打开 网站 主页。发现list页的url都是numbers,内容页的url都是numbers.html

列表页面

内容页

所以正则表达式如下:

列表页面url正则:\/page/[1-9]\d*$

内容页面 url 常规:\/[1-9]\d*.html$

如果只需要采集的前三页的更新内容,只需要将列表页的正则表达式改为\/page/[1-3]$即可。

配置这两个参数时,可以打开“正则表达式在线测试”页面进行测试。

5 文章标题(xpath)/文章内容(xpath):

进入内容页面后,爬虫要选择要爬取的内容,比如文章的标题和文章的正文。所以需要设置xpath来告诉爬虫。

例如:

打开听一页风音,如:。通过浏览器查看页面源码,如图:

可以看到,文章的标题收录在

在这个元素中的元素。所以标题的xpath规则是://h1[@class="mscctitle"]/a

同样,从上图可以看出:内容收录在

在,所以内容的xpath规则是://div[@class="content-text"]

配置完成后,可以打开“XPath在线测试”页面进行测试。

6 内容开始字符串/内容结束字符串:

一般网站的内容中都会有广告,或者其他一些东西混入,所以我们需要过滤掉这些内容,只保存我们需要的部分。大部分无用的东西(广告、分享按钮、标签等)都在文章的开头或结尾,内容是固定的。所以我们可以通过简单的字符串过滤掉。

比如《一起听风》中的每一个文章在内容的开头都有一个广告,如上图。

通过“XPath在线测试”页面测试我们在上一步配置的内容xpath规则,可以得到文章的内容,如下图所示:

如您所见,真正的内容来自

后来就开始了。

所以内容起始字符串设置为:

因为文章的内容后面没有多余的部分,所以后面不用管,把内容结束字符串设置为空即可。

7 文章图片:

采集插件可以自动将出现在文章中的图片保存到本地,默认会按年和月保存在文件夹中,图片的标签设置为文章 的标题。如果不需要本地保存,可以选择“不处理”。

8 文章 分类:

选择要保存到的类别。和 wordpress 一样,你可以选择多个类别。 查看全部

自动采集网站内容(Wordpress自动采集爬虫插件的安装方法及安装)

Crawling是Wordpress下的一个自动采集爬虫插件,可以自动采集爬取目标网站内容并自动发布。

一、 写在前面

首先,我并没有真正参与 PHP。我通常用 C++ 和 Python 编写代码。对于 PHP,我只是在多年前的几天前写博客和写的。最近我换了工作,等待辞职。我无事可做,所以我写了一个插件来娱乐。如果你觉得它不好用,请给我一些建议。我会采纳好的建议,努力把这个插件做得更好。

在开发这个插件的时候,我们已经考虑到尽可能让配置更简单易懂。但是为了让插件更加灵活,还是需要了解regular和xpath的规则。如果你看懂了,相信本教程你一看就懂了,完全没有难度。如果你之前没有接触过regular和xpath,也没关系,因为你其实并不需要了解它,直接看样例文案就行了。因为是第一个版本,有些地方可能写的不详细,请大家指出。

二、下载安装

首先打开下载最新版本得到crawling_v*.tar.gz。

然后,解压压缩包,上传到wordpress插件目录。激活插件。

三、任务管理

一个任务可以理解为一个爬虫,可以配置多个任务,每个任务可以单独设置参数。

比如这里我设置了三个任务,如图:

第一个任务是爬取《一起听风》的全部内容(这是我最喜欢的电影之一网站)。设置爬取间隔为-1意味着只采集一次,不重复执行。

第二个任务是爬取《听风》的前三页。如果采集不重复采集,则只会抓取前三页的更新内容。采集 每 24 小时一次。

第三个任务是爬取“阳光电影网”首页所有更新的电影(这里是电影乐园的新网站),因为阳光电影的所有更新都在首页。采集 每 24 小时一次。

每个任务的参数单独设置,如图:

以下是每个任务的设置:

1 任务名称:

每个任务的别名很容易记住,没有其他作用。

2 入口网址:

每个任务爬虫开始的地址。此 URL 通常是主页或列表页面。然后爬虫会从这个页面采集开始。

3 爬行间隔时间:

运行任务(爬虫)之间的间隔。

4 列出页面url正则/内容页面url正则:

爬虫输入第一个URL(入口URL)后,需要区分哪些内容页面需要采集。所以需要设置匹配内容页面url的正则表达式。

爬行还需要知道如何翻页,找到更多的内容页,所以需要设置列表页url的正则表达式。

例如:抓取“和合风音”整个网站的内容

打开 网站 主页。发现list页的url都是numbers,内容页的url都是numbers.html

列表页面

内容页

所以正则表达式如下:

列表页面url正则:\/page/[1-9]\d*$

内容页面 url 常规:\/[1-9]\d*.html$

如果只需要采集的前三页的更新内容,只需要将列表页的正则表达式改为\/page/[1-3]$即可。

配置这两个参数时,可以打开“正则表达式在线测试”页面进行测试。

5 文章标题(xpath)/文章内容(xpath):

进入内容页面后,爬虫要选择要爬取的内容,比如文章的标题和文章的正文。所以需要设置xpath来告诉爬虫。

例如:

打开听一页风音,如:。通过浏览器查看页面源码,如图:

可以看到,文章的标题收录在

在这个元素中的元素。所以标题的xpath规则是://h1[@class="mscctitle"]/a

同样,从上图可以看出:内容收录在

在,所以内容的xpath规则是://div[@class="content-text"]

配置完成后,可以打开“XPath在线测试”页面进行测试。

6 内容开始字符串/内容结束字符串:

一般网站的内容中都会有广告,或者其他一些东西混入,所以我们需要过滤掉这些内容,只保存我们需要的部分。大部分无用的东西(广告、分享按钮、标签等)都在文章的开头或结尾,内容是固定的。所以我们可以通过简单的字符串过滤掉。

比如《一起听风》中的每一个文章在内容的开头都有一个广告,如上图。

通过“XPath在线测试”页面测试我们在上一步配置的内容xpath规则,可以得到文章的内容,如下图所示:

如您所见,真正的内容来自

后来就开始了。

所以内容起始字符串设置为:

因为文章的内容后面没有多余的部分,所以后面不用管,把内容结束字符串设置为空即可。

7 文章图片:

采集插件可以自动将出现在文章中的图片保存到本地,默认会按年和月保存在文件夹中,图片的标签设置为文章 的标题。如果不需要本地保存,可以选择“不处理”。

8 文章 分类:

选择要保存到的类别。和 wordpress 一样,你可以选择多个类别。

自动采集网站内容(网页采集是什么,又是如何采集的呢?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-10-25 04:07

在网页设计中,什么是网页采集,它是怎样的采集?

网页采集作为政府网站网页在线存档的主要环节,就是利用相关工具,按照既定的频率和方法,及时筛选出值得保存的政府网页内容。网页采集的第一步是确定采集的对象,政府网页采集中存储的信息是域名中带有""的政府网站 ,为了保证政府网页采集的质量,需要对目标网站进行评价,信息量大、原创信息较多、更新频繁的政府网站是被选为 采集 的目标。确定目标政府网站到采集后,对应的采集 方法也应根据实际需要选择。更多seo和网站建设案例可以在我们的官网查看:

完整性采集和选择性采集是目前比较常用的网络资源采集方法。他们每个人都有自己的优点和缺点。为了弥补自身的不足,可以实现两种采集@。>方法优势互补,采用混合采集方法,综合两者的优点,同时完成所选政府所有网页的完整性网站,同时通过人工干预对网页内容进行一定程度的筛选,对具有证据价值、历史价值、研究价值的重要网页进行选择性、频繁的采集深度挖掘,兼顾政府网页< @采集 面对广度,

采集 和网页的抓取最终需要通过相应的网络爬虫工具来实现。目前,网页归档的爬虫工具有很多。其中Heritrix和HTTrack是最常用的。这些工具可用于执行有针对性的匹配。目标政府网站网页自动批量在线采集。 查看全部

自动采集网站内容(网页采集是什么,又是如何采集的呢?(图))

在网页设计中,什么是网页采集,它是怎样的采集?

网页采集作为政府网站网页在线存档的主要环节,就是利用相关工具,按照既定的频率和方法,及时筛选出值得保存的政府网页内容。网页采集的第一步是确定采集的对象,政府网页采集中存储的信息是域名中带有""的政府网站 ,为了保证政府网页采集的质量,需要对目标网站进行评价,信息量大、原创信息较多、更新频繁的政府网站是被选为 采集 的目标。确定目标政府网站到采集后,对应的采集 方法也应根据实际需要选择。更多seo和网站建设案例可以在我们的官网查看:

完整性采集和选择性采集是目前比较常用的网络资源采集方法。他们每个人都有自己的优点和缺点。为了弥补自身的不足,可以实现两种采集@。>方法优势互补,采用混合采集方法,综合两者的优点,同时完成所选政府所有网页的完整性网站,同时通过人工干预对网页内容进行一定程度的筛选,对具有证据价值、历史价值、研究价值的重要网页进行选择性、频繁的采集深度挖掘,兼顾政府网页< @采集 面对广度,

采集 和网页的抓取最终需要通过相应的网络爬虫工具来实现。目前,网页归档的爬虫工具有很多。其中Heritrix和HTTrack是最常用的。这些工具可用于执行有针对性的匹配。目标政府网站网页自动批量在线采集。

自动采集网站内容(自动采集网站内容。。花个两三天去google下吧!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-10-24 08:00

自动采集网站内容。

花个两三天去google下吧!还是有不少!我是站长,我用两个软件在互相配合着,干掉了好多坑!第一个是,sofasofa,下面是我用sofasofa做的一个爬虫。第二个是,圣经倒是可以,第三个是知道叫啥,第四个是,

数据结构与算法

去图书馆查查机器语言、结构体、数组和指针、线程、多线程等的主页和相关书籍,上面都介绍的很详细。如果是面向对象的程序设计,推荐javaprimer,不是推荐你买那本书,毕竟书贵,java的入门书籍并不多,不要为了买书而买书,买来的书看完了可以再买一本,实在想买书,推荐,刘汝佳的《疯狂java讲义》。另外现在学算法课程,还推荐算法导论。

实际工作里,各种各样奇奇怪怪的名词和东西很多,像闭包,栈,队列,堆,缓冲区,堆位,迭代器等等,更别说各种局部变量,全局变量,函数指针,虚函数等了。个人觉得反正人人都有对数据结构和算法的兴趣,大家都在网上看有关数据结构和算法的视频,视频里都会介绍这些数据结构和算法,未必你不会,反正视频是给谁看的大家心里应该有数。如果实在看不懂或者实在不感兴趣,对不起,那么买本java的工具书,比如《java编程思想》。

thinkinjava以及thinkinc++,c#我看了一遍,对数据结构有了一个总体的了解,我推荐这两本书,再看下面的东西。 查看全部

自动采集网站内容(自动采集网站内容。。花个两三天去google下吧!)

自动采集网站内容。

花个两三天去google下吧!还是有不少!我是站长,我用两个软件在互相配合着,干掉了好多坑!第一个是,sofasofa,下面是我用sofasofa做的一个爬虫。第二个是,圣经倒是可以,第三个是知道叫啥,第四个是,

数据结构与算法

去图书馆查查机器语言、结构体、数组和指针、线程、多线程等的主页和相关书籍,上面都介绍的很详细。如果是面向对象的程序设计,推荐javaprimer,不是推荐你买那本书,毕竟书贵,java的入门书籍并不多,不要为了买书而买书,买来的书看完了可以再买一本,实在想买书,推荐,刘汝佳的《疯狂java讲义》。另外现在学算法课程,还推荐算法导论。

实际工作里,各种各样奇奇怪怪的名词和东西很多,像闭包,栈,队列,堆,缓冲区,堆位,迭代器等等,更别说各种局部变量,全局变量,函数指针,虚函数等了。个人觉得反正人人都有对数据结构和算法的兴趣,大家都在网上看有关数据结构和算法的视频,视频里都会介绍这些数据结构和算法,未必你不会,反正视频是给谁看的大家心里应该有数。如果实在看不懂或者实在不感兴趣,对不起,那么买本java的工具书,比如《java编程思想》。

thinkinjava以及thinkinc++,c#我看了一遍,对数据结构有了一个总体的了解,我推荐这两本书,再看下面的东西。

自动采集网站内容(无人值守免费自动采集器绿色免费版(简称ET)(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-10-24 07:13

无人值守免费自动采集器绿色免费版(ET)以提高软件自动化程度为突破口,达到无人值守免费自动采集器绿色免费版,24小时自动的目的工作,经测试,ET可以长时间自动运行,甚至以(yi)年为时间单位。无人值守免费自动采集器绿色免费版独立于网站,不消耗宝贵的服务器WEB处理资源,可以在服务器上工作,也可以在站长的工作机上工作。无人值守免费自动采集器绿色免费版使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免任何数据造成by ET 安全问题的可能性。 采集使用消息(xin)时,ET使用标准的HTTP端口,不会造成网络安全漏洞。 ET除了具有一般采集工具的功能外,还使用了图片水印、防盗链、分页采集、回复采集、登录采集、自定义物品、UTF- 8、UBB的支持,模拟发布...使用户可以灵活实现各种采购和开发需求。

无人值守免费自动采集器绿色免费版介绍

<p>1. 特点 1、 设置计划,可以24小时自动工作,不再需要人工干预2、和网站分离,通过独立的制作界面,可以支持任何网站或数据库3、灵活强大的采集规则不仅是采集文章,而是采集任何类型的信息4、体积小,低功耗,稳定性好,非常适合在服务器上运行5、所有规则均可导入导出,资源灵活复用6、使用FTP上传文件,稳定安全< @7、下载上传支持断点续传8、高速伪原创 ,可选择反向、顺序、随机采集文章2、支持自动list URL3、支持采集4、数据分布在多个页面网站自由设置采集数据项,每个数据项都可以过滤排序单独5、支持分页内容采集6、支持任意格式和类型的文件(包括图片、视频)下载 查看全部

自动采集网站内容(无人值守免费自动采集器绿色免费版(简称ET)(组图))

无人值守免费自动采集器绿色免费版(ET)以提高软件自动化程度为突破口,达到无人值守免费自动采集器绿色免费版,24小时自动的目的工作,经测试,ET可以长时间自动运行,甚至以(yi)年为时间单位。无人值守免费自动采集器绿色免费版独立于网站,不消耗宝贵的服务器WEB处理资源,可以在服务器上工作,也可以在站长的工作机上工作。无人值守免费自动采集器绿色免费版使用网站自己的数据发布接口或程序代码来处理和发布信息内容,不直接操作网站数据库,避免任何数据造成by ET 安全问题的可能性。 采集使用消息(xin)时,ET使用标准的HTTP端口,不会造成网络安全漏洞。 ET除了具有一般采集工具的功能外,还使用了图片水印、防盗链、分页采集、回复采集、登录采集、自定义物品、UTF- 8、UBB的支持,模拟发布...使用户可以灵活实现各种采购和开发需求。

无人值守免费自动采集器绿色免费版介绍

<p>1. 特点 1、 设置计划,可以24小时自动工作,不再需要人工干预2、和网站分离,通过独立的制作界面,可以支持任何网站或数据库3、灵活强大的采集规则不仅是采集文章,而是采集任何类型的信息4、体积小,低功耗,稳定性好,非常适合在服务器上运行5、所有规则均可导入导出,资源灵活复用6、使用FTP上传文件,稳定安全< @7、下载上传支持断点续传8、高速伪原创 ,可选择反向、顺序、随机采集文章2、支持自动list URL3、支持采集4、数据分布在多个页面网站自由设置采集数据项,每个数据项都可以过滤排序单独5、支持分页内容采集6、支持任意格式和类型的文件(包括图片、视频)下载

自动采集网站内容(撸手机app的钱,我也试过,真的很简单)

采集交流 • 优采云 发表了文章 • 0 个评论 • 178 次浏览 • 2021-10-21 16:02

自动采集网站内容然后智能分析就可以赚钱的平台已经很多了,平台运营好了,是可以赚钱的,然后是有门槛的,要技术含量的。不妨来试试的。不知道网站可以关注我哦,我的个人时间更多,更专业,你也可以尽早加入我的行列。

撸手机app的钱,我也试过,真的很简单,手机版的,

不知道你说的是图文上传还是要转码,知道的有加源站收益的,

图文上传啊,正规图文收录直接百度搜标题都可以直接拿到流量的,除了这些还有点击分成的,qq空间点击分成啊,

云丰网:红包+交易

图文自媒体发布的基本盈利模式主要包括两种:一种为卖内容或推广文章,包括发布到各大自媒体平台等。另一种是为广告客户提供内容。这种模式的收益来源主要是来自平台的广告分成。

ip浏览,加广告,收钱都不难的。

云丰网

做自媒体,一个好的领域,运营的好,轻松月入过万,但前提是内容还得过关。在比如:司空导航网做司空导航,收益是不错的,但是它虽然收益高,但是也非常的辛苦。因为他有品牌包装、发展潜力、同行关系、签约主播、粉丝粘性、统计分析等,每一步都是非常严谨的。再比如:土豆这个平台,是由土豆影视、美国大片电影、日本av、韩国综艺等50多位明星来领导,其实收益也很高,但是在和商务方面还不是很过关,这个还得自己努力。

当然一个好的领域很重要,做了云丰网。一个月10000+就是没问题。所以自媒体真的很赚钱,不要急于求成,每一步都很关键,不走弯路。 查看全部

自动采集网站内容(撸手机app的钱,我也试过,真的很简单)

自动采集网站内容然后智能分析就可以赚钱的平台已经很多了,平台运营好了,是可以赚钱的,然后是有门槛的,要技术含量的。不妨来试试的。不知道网站可以关注我哦,我的个人时间更多,更专业,你也可以尽早加入我的行列。

撸手机app的钱,我也试过,真的很简单,手机版的,

不知道你说的是图文上传还是要转码,知道的有加源站收益的,

图文上传啊,正规图文收录直接百度搜标题都可以直接拿到流量的,除了这些还有点击分成的,qq空间点击分成啊,

云丰网:红包+交易

图文自媒体发布的基本盈利模式主要包括两种:一种为卖内容或推广文章,包括发布到各大自媒体平台等。另一种是为广告客户提供内容。这种模式的收益来源主要是来自平台的广告分成。

ip浏览,加广告,收钱都不难的。

云丰网

做自媒体,一个好的领域,运营的好,轻松月入过万,但前提是内容还得过关。在比如:司空导航网做司空导航,收益是不错的,但是它虽然收益高,但是也非常的辛苦。因为他有品牌包装、发展潜力、同行关系、签约主播、粉丝粘性、统计分析等,每一步都是非常严谨的。再比如:土豆这个平台,是由土豆影视、美国大片电影、日本av、韩国综艺等50多位明星来领导,其实收益也很高,但是在和商务方面还不是很过关,这个还得自己努力。

当然一个好的领域很重要,做了云丰网。一个月10000+就是没问题。所以自媒体真的很赚钱,不要急于求成,每一步都很关键,不走弯路。

自动采集网站内容(做互联网不懂怎么制作网站,不会弄网页游戏怎么行?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-10-20 14:01

自动采集网站内容,一键发布到百度新闻、百度文库、百度经验等等网站。做互联网,不懂怎么制作网站,不会弄网页游戏怎么行?以后工作更方便,效率会提高很多。

简单啊,关注各大论坛的qq群,

百度文库嘛。你都能搜到,或者叫你搜搜腾讯文档,有时间可以找个文档,

百度文库,

可以百度文库的网站上看看,会有很多材料。

找我啊!

你搜搜大斌网,好久没上,里面有很多百度文库,除了那种电子出版物,大多数不足都是给大学生做毕业设计或者小的设计公司的外包项目,据我所知,给大学生设计海报,电子设计都还蛮好的,

不邀自来,前些天做了个关于2017年全国图书馆普查的统计,也就是通俗意义上的人文社科类书籍,

自己没事找点事做呗,多总结前人已经做过的总结,

我只能说去百度文库搜。

我这里有900w.直接上连接:(超级给力的)点击链接;a=baidu&s=0200568(正在整理...有点慢...要耐心的等)

明确的告诉你,来这儿就对了。你随便挑一本,看看书名,再看一看内容。就知道他是不是我要找的了。

看了之后,不想多答一句,关于这类问题,知乎只能提供平台,没法给出具体操作。祝好。 查看全部

自动采集网站内容(做互联网不懂怎么制作网站,不会弄网页游戏怎么行?)

自动采集网站内容,一键发布到百度新闻、百度文库、百度经验等等网站。做互联网,不懂怎么制作网站,不会弄网页游戏怎么行?以后工作更方便,效率会提高很多。

简单啊,关注各大论坛的qq群,

百度文库嘛。你都能搜到,或者叫你搜搜腾讯文档,有时间可以找个文档,

百度文库,

可以百度文库的网站上看看,会有很多材料。

找我啊!

你搜搜大斌网,好久没上,里面有很多百度文库,除了那种电子出版物,大多数不足都是给大学生做毕业设计或者小的设计公司的外包项目,据我所知,给大学生设计海报,电子设计都还蛮好的,

不邀自来,前些天做了个关于2017年全国图书馆普查的统计,也就是通俗意义上的人文社科类书籍,

自己没事找点事做呗,多总结前人已经做过的总结,

我只能说去百度文库搜。

我这里有900w.直接上连接:(超级给力的)点击链接;a=baidu&s=0200568(正在整理...有点慢...要耐心的等)

明确的告诉你,来这儿就对了。你随便挑一本,看看书名,再看一看内容。就知道他是不是我要找的了。

看了之后,不想多答一句,关于这类问题,知乎只能提供平台,没法给出具体操作。祝好。

自动采集网站内容(pt聚合tp5仿阿里巴巴小说站安装使用需一丢丢代码基础)

采集交流 • 优采云 发表了文章 • 0 个评论 • 137 次浏览 • 2021-10-19 05:09

本源码已被出资者购买,未开源!如果您之前下载过初始版本,请不要传播,以免给我带来麻烦,谢谢

免责声明:本网站的安装和使用需要丢失代码基础。如果没有基础(比如不懂tinkphp,连数据库都找不到),不推荐这段代码!推荐使用杰奇,pt聚合

tp5仿阿里巴巴小说网站,链接:

前端pc模仿阿里巴巴小说网站,wap模仿言情小说,后端前端使用x-admin框架。具体效果如下:

基于tp5.0的写法,实现小说自动采集!

环境要求:php5.5,需要开启伪静态

安装:直接放在php环境的根目录下,访问public目录下的index.php文件,

后台地址:网站地址后添加admin.php(如你的网站/admin.php),默认账号密码为:admin,admin

安装完成后需要配置:畅言账号(如果没有配置,网站将无法评论) 邮件服务(如果没有配置,网站将无法评论)注册)

安装完成后点击后面采集管理中的采集小说,就可以采集小说了,采集规则已经配置好了,自动采集起点小说站小说,如果是linux服务器请配置public\static\images\books_img下文件的读写权限

数据库文件:根目录下的new_books.sql文件

本站仅供个人学习,如有不足之处还望指出!

根据这个源码亲自搭建了一个小说网站: 查看全部

自动采集网站内容(pt聚合tp5仿阿里巴巴小说站安装使用需一丢丢代码基础)

本源码已被出资者购买,未开源!如果您之前下载过初始版本,请不要传播,以免给我带来麻烦,谢谢

免责声明:本网站的安装和使用需要丢失代码基础。如果没有基础(比如不懂tinkphp,连数据库都找不到),不推荐这段代码!推荐使用杰奇,pt聚合

tp5仿阿里巴巴小说网站,链接:

前端pc模仿阿里巴巴小说网站,wap模仿言情小说,后端前端使用x-admin框架。具体效果如下:

基于tp5.0的写法,实现小说自动采集!

环境要求:php5.5,需要开启伪静态

安装:直接放在php环境的根目录下,访问public目录下的index.php文件,

后台地址:网站地址后添加admin.php(如你的网站/admin.php),默认账号密码为:admin,admin

安装完成后需要配置:畅言账号(如果没有配置,网站将无法评论) 邮件服务(如果没有配置,网站将无法评论)注册)

安装完成后点击后面采集管理中的采集小说,就可以采集小说了,采集规则已经配置好了,自动采集起点小说站小说,如果是linux服务器请配置public\static\images\books_img下文件的读写权限

数据库文件:根目录下的new_books.sql文件

本站仅供个人学习,如有不足之处还望指出!

根据这个源码亲自搭建了一个小说网站:

自动采集网站内容(自荐一下,优采云采集平台(图)采集(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2021-10-19 05:05

自我推荐,优采云采集平台将数据采集+数据处理+SEO+自动化+输出(发布网站、导出excel等)有机整合成一个整体,使得功能更加集成,更易于使用。

优采云采集 有免费版,有需要有兴趣的同学可以看快速入门文档体验:

回到采集过程中自动过滤数据的主要话题,优采云采集提供了九种数据处理功能:

1、常用删除&填充:支持快速删除图片或链接,填充字段前后内容(如版权声明),也可以引用同一条数据的其他字段内容。

2、 字符替换:主要功能是替换或删除字符,支持正则语法。

3、HTML标签删除:用于删除HTML标签,可以指定位置和数量,支持保留文本。

4、常用截取&提取:使用正则表达式提取或替换内容,内置常用正则表达式提取,如:日期、数字、URL、数字,截取前X个字符获取第二张图片链接,等等。 。

5、随机值&固定值:可以为字段设置固定值或随机值,包括随机数、随机时间、随机字符串等。

6、内容过滤:根据采集结果的内容或文本长度判断数据是否存入数据库采集;

7、HTML标签过滤:可以过滤指定的HTML标签,如table、hr、img等。

8、高级提取:高级提取可以设置采集不显示页面内容,比如获取URL、图片链接、HTML标签某些属性的值等;

9、结果数据批量修改工具,对于采集结果数据,系统提供灵活的数据二次处理,快速批量完成一些耗时的操作。数据替换、填充、拦截、删除等批量操作。输入一个任务,切换到“Result Data & Release”选项卡,点击“Batch Edit Tool”,选择需要批量处理的函数,如下图:

详细文档如下: 查看全部

自动采集网站内容(自荐一下,优采云采集平台(图)采集(组图))

自我推荐,优采云采集平台将数据采集+数据处理+SEO+自动化+输出(发布网站、导出excel等)有机整合成一个整体,使得功能更加集成,更易于使用。

优采云采集 有免费版,有需要有兴趣的同学可以看快速入门文档体验:

回到采集过程中自动过滤数据的主要话题,优采云采集提供了九种数据处理功能:

1、常用删除&填充:支持快速删除图片或链接,填充字段前后内容(如版权声明),也可以引用同一条数据的其他字段内容。

2、 字符替换:主要功能是替换或删除字符,支持正则语法。

3、HTML标签删除:用于删除HTML标签,可以指定位置和数量,支持保留文本。

4、常用截取&提取:使用正则表达式提取或替换内容,内置常用正则表达式提取,如:日期、数字、URL、数字,截取前X个字符获取第二张图片链接,等等。 。

5、随机值&固定值:可以为字段设置固定值或随机值,包括随机数、随机时间、随机字符串等。

6、内容过滤:根据采集结果的内容或文本长度判断数据是否存入数据库采集;

7、HTML标签过滤:可以过滤指定的HTML标签,如table、hr、img等。

8、高级提取:高级提取可以设置采集不显示页面内容,比如获取URL、图片链接、HTML标签某些属性的值等;

9、结果数据批量修改工具,对于采集结果数据,系统提供灵活的数据二次处理,快速批量完成一些耗时的操作。数据替换、填充、拦截、删除等批量操作。输入一个任务,切换到“Result Data & Release”选项卡,点击“Batch Edit Tool”,选择需要批量处理的函数,如下图:

详细文档如下:

自动采集网站内容(自动采集网站内容是会计做账的基础,具体的操作方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-10-14 10:00

自动采集网站内容是会计做账的基础,会计上每月要有自己主体的业务,自己单位的账务,在其中采集到的内容就是自己单位的业务流水、人员流动及公司产品的宣传片、陈列片等等,这些都是根据实际业务自动获取。具体的操作方法可以看我经常发的文章。做账流程对于一个公司来说,就比较专业了,如果新人入行没有做账经验,就先学做账流程吧,有些操作要去学,如果对专业不感兴趣,则不需要去学。

全国开网站时间集中在春季和秋季,百度上可以搜索到一些推荐的公司。

地址留邮箱

邮件推广,

自己买二手空调,一年采购额大概在几十万,空调售价17-19万,空调出货量少的话,

我想要给母亲或者兄弟姐妹买套房子,

个人表示,每个人都可以开网站,而且因为生活在互联网的连接下,需要积累和形成自己的网站。工作地点比较分散。

多少有点用,要多看看这行业,不要只看打工。可以当做副业。

你想说做erp系统吧

采购物品网站商城有些大的物流公司也会收有些小的物流公司或者自己就是物流公司只有包仓了也不单独采购一般都是买其他的

有用的。采购物品网站商城或者商户网购平台有些平台通过b2b2c模式,把需要采购的商家资源提供给商户。商户就自己发布商品,供购买人选择和浏览,这个网站商城商户自己做了渠道了。一般都在经销商那一方。还有通过b2b2c或者直接厂家库存,小的商户资源提供给经销商,经销商做了渠道。再采购一些产品和服务作为自己的渠道。 查看全部

自动采集网站内容(自动采集网站内容是会计做账的基础,具体的操作方法)

自动采集网站内容是会计做账的基础,会计上每月要有自己主体的业务,自己单位的账务,在其中采集到的内容就是自己单位的业务流水、人员流动及公司产品的宣传片、陈列片等等,这些都是根据实际业务自动获取。具体的操作方法可以看我经常发的文章。做账流程对于一个公司来说,就比较专业了,如果新人入行没有做账经验,就先学做账流程吧,有些操作要去学,如果对专业不感兴趣,则不需要去学。

全国开网站时间集中在春季和秋季,百度上可以搜索到一些推荐的公司。

地址留邮箱

邮件推广,

自己买二手空调,一年采购额大概在几十万,空调售价17-19万,空调出货量少的话,

我想要给母亲或者兄弟姐妹买套房子,

个人表示,每个人都可以开网站,而且因为生活在互联网的连接下,需要积累和形成自己的网站。工作地点比较分散。

多少有点用,要多看看这行业,不要只看打工。可以当做副业。

你想说做erp系统吧

采购物品网站商城有些大的物流公司也会收有些小的物流公司或者自己就是物流公司只有包仓了也不单独采购一般都是买其他的

有用的。采购物品网站商城或者商户网购平台有些平台通过b2b2c模式,把需要采购的商家资源提供给商户。商户就自己发布商品,供购买人选择和浏览,这个网站商城商户自己做了渠道了。一般都在经销商那一方。还有通过b2b2c或者直接厂家库存,小的商户资源提供给经销商,经销商做了渠道。再采购一些产品和服务作为自己的渠道。

自动采集网站内容(#全网网址采集器全网可用在哪里运行本采集器可用运行 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-10-11 11:03

)

整个网站采集器(蜘蛛网)

这是一个由golang编写的网站采集器,可以自动抓取所有可以到达的网站信息。网站采集器会自动分析采集的标题、网站描述、微信、QQ、网站的联系方式、网站使用的运行环境、ip信息等., 甚至 网站 使用的框架。

全新升级,使用sqlite作为数据库,不再需要安装mysql,直接运行可执行文件即可抓取内容。

为什么会有这样的全网网站采集器全网网站采集器可以采集什么内容

这个采集器可以是采集的内容有:文章标题、文章关键词、文章描述、文章详细内容,文章作者,文章发布时间,文章浏览量。

##我可以在哪里运行这个网站采集器我可以在哪里运行这个网站采集器它可以在Windows、Mac、Linux(Centos、Ubuntu等)上运行,你可以下载编译好的程序直接执行,也可以下载源码自己编译。

如何安装和使用

go env -w GOPROXY=https://goproxy.cn,direct

最后执行如下命令

go mod tidy

go mod vendor

go build app/main.go

## 跨平台编译Windows版本

CGO_ENABLED=1 CC=x86_64-w64-mingw32-gcc CXX=x86_64-w64-mingw32-g++ GOOS=windows GOARCH=amd64 go build -x -v -ldflags "-s -w" -o cobweb.exe ./app/main.go 查看全部

自动采集网站内容(#全网网址采集器全网可用在哪里运行本采集器可用运行

)

整个网站采集器(蜘蛛网)

这是一个由golang编写的网站采集器,可以自动抓取所有可以到达的网站信息。网站采集器会自动分析采集的标题、网站描述、微信、QQ、网站的联系方式、网站使用的运行环境、ip信息等., 甚至 网站 使用的框架。

全新升级,使用sqlite作为数据库,不再需要安装mysql,直接运行可执行文件即可抓取内容。

为什么会有这样的全网网站采集器全网网站采集器可以采集什么内容

这个采集器可以是采集的内容有:文章标题、文章关键词、文章描述、文章详细内容,文章作者,文章发布时间,文章浏览量。

##我可以在哪里运行这个网站采集器我可以在哪里运行这个网站采集器它可以在Windows、Mac、Linux(Centos、Ubuntu等)上运行,你可以下载编译好的程序直接执行,也可以下载源码自己编译。

如何安装和使用

go env -w GOPROXY=https://goproxy.cn,direct

最后执行如下命令

go mod tidy

go mod vendor

go build app/main.go

## 跨平台编译Windows版本

CGO_ENABLED=1 CC=x86_64-w64-mingw32-gcc CXX=x86_64-w64-mingw32-g++ GOOS=windows GOARCH=amd64 go build -x -v -ldflags "-s -w" -o cobweb.exe ./app/main.go

自动采集网站内容(自动采集网站内容技术文章,阿里妈妈采集器使用起来)

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-10-08 01:01

自动采集网站内容技术文章

一、收集网站爬虫以及自动采集商品数据的方法,阿里妈妈采集器,使用起来简单方便的工具。

1、登录阿里妈妈采集器:①进入页面,点击进入下一步②在此页面输入网址,

二、自动采集商品数据具体教程

1、在浏览器中输入商品网址,并采集和筛选中间含有“/”的网页内容。

2、获取商品历史销量数据,并单击红框中的下拉列表。

3、获取宝贝的价格,即商品价格。

4、用鼠标左键复制以下代码,粘贴到自动采集的后面。复制好之后,点击下一步即可。

5、待自动采集成功后,只需点击下一步,最后点击打开网即可。

联想地图导航

qq浏览器就有浏览器浏览器输入qq浏览器的链接直接复制粘贴

哎呀网-手机网址导航,打开新世界

不多说直接上链接好了

楼上的都是错的你们都不知道回车就能跳转吗!

需要下载一个app【立即下载】好用到爆!~

千聊听课

我推荐用百度网盘搜索

/

你可以试试我们家的互联网产品,每天一篇资讯。快速找到每天的热点,并且提供个性化的新闻推荐,找到那些值得关注的。每天的推荐热点也会更新,更符合年轻人的口味。

谢邀?我也不知道,题主好好提问, 查看全部

自动采集网站内容(自动采集网站内容技术文章,阿里妈妈采集器使用起来)

自动采集网站内容技术文章

一、收集网站爬虫以及自动采集商品数据的方法,阿里妈妈采集器,使用起来简单方便的工具。

1、登录阿里妈妈采集器:①进入页面,点击进入下一步②在此页面输入网址,

二、自动采集商品数据具体教程

1、在浏览器中输入商品网址,并采集和筛选中间含有“/”的网页内容。

2、获取商品历史销量数据,并单击红框中的下拉列表。

3、获取宝贝的价格,即商品价格。

4、用鼠标左键复制以下代码,粘贴到自动采集的后面。复制好之后,点击下一步即可。

5、待自动采集成功后,只需点击下一步,最后点击打开网即可。

联想地图导航

qq浏览器就有浏览器浏览器输入qq浏览器的链接直接复制粘贴

哎呀网-手机网址导航,打开新世界

不多说直接上链接好了

楼上的都是错的你们都不知道回车就能跳转吗!

需要下载一个app【立即下载】好用到爆!~

千聊听课

我推荐用百度网盘搜索

/

你可以试试我们家的互联网产品,每天一篇资讯。快速找到每天的热点,并且提供个性化的新闻推荐,找到那些值得关注的。每天的推荐热点也会更新,更符合年轻人的口味。

谢邀?我也不知道,题主好好提问,

自动采集网站内容(自动采集网站内容的软件开发应该没有,但是通过采集别人的内容来发表)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-10-03 02:02

自动采集网站内容的软件开发应该没有,但是通过采集别人的内容来发表,这个还是很多的,下面就给大家推荐一个较好的方法——数据下载网。网址是:数据下载网网址很简单,就是不停的复制,发表页面的内容复制到网址里面,其他页面的内容复制到下面三个地方就可以了(去重比例与别人复制网址设置的去重比例一致就ok)。现在开发的软件很多,软件采集什么的还有一些是比较大的网站和app都可以,如果能懂一些网站爬虫的原理的话就更好了,爬虫这块我目前才刚入门,可以找懂爬虫的人一起学习。

常用的就是spider和shuaxia最新的有pixabay和pornhub,想学的话从官网下也可以用爬虫实现。

beautifulsoup这个是我用的比较多的网站采集工具。首先需要有一个html代码来实现你网站的爬取功能。然后把爬取下来的数据保存到本地用本地工具对数据进行解析。然后把处理后的数据发布到p2p平台。也有ssp平台。

beautifulsoupbs=beautifulsoup(html,text(),"lxml")re=bs(string,text(),"lxml")foriinre:ifi!=".":continueresult=bs(re.findall(i,""),string)print(i)

<p>01-requestsimportrequestsimportresoup=beautifulsoup(pile(" 查看全部

自动采集网站内容(自动采集网站内容的软件开发应该没有,但是通过采集别人的内容来发表)

自动采集网站内容的软件开发应该没有,但是通过采集别人的内容来发表,这个还是很多的,下面就给大家推荐一个较好的方法——数据下载网。网址是:数据下载网网址很简单,就是不停的复制,发表页面的内容复制到网址里面,其他页面的内容复制到下面三个地方就可以了(去重比例与别人复制网址设置的去重比例一致就ok)。现在开发的软件很多,软件采集什么的还有一些是比较大的网站和app都可以,如果能懂一些网站爬虫的原理的话就更好了,爬虫这块我目前才刚入门,可以找懂爬虫的人一起学习。

常用的就是spider和shuaxia最新的有pixabay和pornhub,想学的话从官网下也可以用爬虫实现。

beautifulsoup这个是我用的比较多的网站采集工具。首先需要有一个html代码来实现你网站的爬取功能。然后把爬取下来的数据保存到本地用本地工具对数据进行解析。然后把处理后的数据发布到p2p平台。也有ssp平台。

beautifulsoupbs=beautifulsoup(html,text(),"lxml")re=bs(string,text(),"lxml")foriinre:ifi!=".":continueresult=bs(re.findall(i,""),string)print(i)

<p>01-requestsimportrequestsimportresoup=beautifulsoup(pile("