网页采集器的自动识别算法

优采云采集器 v8.1.12.4273 官方版

采集交流 • 优采云 发表了文章 • 0 个评论 • 370 次浏览 • 2020-08-10 03:50

怎么判别优采云采集器能采集什么信息呢?

简易而言,你可以在网页上看到的信息,优采云采集器均能进行采集,实际采集标准想要你自主设定或从标准销售市场内免费下载。

配备采集步骤时,有时左键点一下一个联接,弹下来选择项的情况下网页会跳转,怎样避免网页跳转?

某些应用脚本制做操纵手动跳转的网页将会会在点一下左键的情况下手动跳转, 给配备导致不变, 解决方案是应用右键单击, 以上键单击网页都是弹下来选择项,沒有一切差距。鼠标右键点一下通常还能 防止跳转的困局。

优采云采集器安裝取得成功后未能启动该如何办?

假如初次安裝取得成功后起动提醒“Windows早已配备优采云采集器,请稍后”,而且之后出現提醒“安裝时带来出错”,而且您的笔记本有360安全护卫等相仿笔记本软件早已运作,则将会是因为360等笔记本杀毒软件不正确的删掉了优采云运作所须要的文档,请撤离360等笔记本杀毒软件,重装优采云采集器就可以。 操作方法

先你们在建一个每日任务-->进到步骤设计方案网页页面-->加上一个循环系统流程到步骤中-->选定循环系统流程-->启用上笔记本软件两侧的URL 目录勾选框-->开启URL目录输入框-->将打算好的URL目录填好到输入框中

接下去往循环系统中拖进一个开启网页的流程-->选定开启网页流程-->启用上应用现今循环系统里的URL做为导航地址-->点一下存储。系统软件会在页面正下方的笔记本浏览器中开启循环系统中选取的URL相匹配的网页

。

到这儿,循环系统开启网页的步骤就配备完成了,运作步骤的情况下,系统软件会逐一的开启循环系统中设定的URL。最终你们不用配备一个采集数据信息的流程,这里就没有多讲,大伙儿才能 参照从菜鸟入门到熟练系列产品1:采集单独网页 本文。下面的图便是最后和步骤

下边是步骤最后的运作結果

版本更新V7.6.0(宣布) 2019-01-04

关键体验改善

【自定形式】增加JSON采集功能

【自定形式】增加滑动验证码鉴定

【自定形式】 提升高效率,目录鉴定速度翻倍

【自定形式】自动检索网页Ajax点一下,全手动配备Ajax恳求超时時间,配备每日任务更便捷

【自定形式】改善优化算法,挑选网页原素更精确

【当地采集】采集速率总体提升10~30%,采集高效率大幅度提升

【任务列表】重新建立任务列表页面,大幅度提升特点主要表现,很多任务管理器已不卡屏

【任务列表】任务列表添加手动更新体制,可随时随地查询每日任务全新情况

Bug修复

修补云采集查询数据信息迟滞困局

修补采集错误报告 排版设计衰弱困局

修补「开启网页时侯出現错码」难题

修补拖放步骤后突然消散的困局

修补定时执行导下来、全手动进库专用工具自弹出出困局

修补备份時间种类数据信息错误困局 查看全部

能采集,一切你仍然在网页可以看见的数据信息都还能采集,优采云采集器内嵌的标准销售市场中也有好多该类标准可免费下载,不用配备,运作标准就可以获取到这些数据信息。

怎么判别优采云采集器能采集什么信息呢?

简易而言,你可以在网页上看到的信息,优采云采集器均能进行采集,实际采集标准想要你自主设定或从标准销售市场内免费下载。

配备采集步骤时,有时左键点一下一个联接,弹下来选择项的情况下网页会跳转,怎样避免网页跳转?

某些应用脚本制做操纵手动跳转的网页将会会在点一下左键的情况下手动跳转, 给配备导致不变, 解决方案是应用右键单击, 以上键单击网页都是弹下来选择项,沒有一切差距。鼠标右键点一下通常还能 防止跳转的困局。

优采云采集器安裝取得成功后未能启动该如何办?

假如初次安裝取得成功后起动提醒“Windows早已配备优采云采集器,请稍后”,而且之后出現提醒“安裝时带来出错”,而且您的笔记本有360安全护卫等相仿笔记本软件早已运作,则将会是因为360等笔记本杀毒软件不正确的删掉了优采云运作所须要的文档,请撤离360等笔记本杀毒软件,重装优采云采集器就可以。 操作方法

先你们在建一个每日任务-->进到步骤设计方案网页页面-->加上一个循环系统流程到步骤中-->选定循环系统流程-->启用上笔记本软件两侧的URL 目录勾选框-->开启URL目录输入框-->将打算好的URL目录填好到输入框中

接下去往循环系统中拖进一个开启网页的流程-->选定开启网页流程-->启用上应用现今循环系统里的URL做为导航地址-->点一下存储。系统软件会在页面正下方的笔记本浏览器中开启循环系统中选取的URL相匹配的网页

。

到这儿,循环系统开启网页的步骤就配备完成了,运作步骤的情况下,系统软件会逐一的开启循环系统中设定的URL。最终你们不用配备一个采集数据信息的流程,这里就没有多讲,大伙儿才能 参照从菜鸟入门到熟练系列产品1:采集单独网页 本文。下面的图便是最后和步骤

下边是步骤最后的运作結果

版本更新V7.6.0(宣布) 2019-01-04

关键体验改善

【自定形式】增加JSON采集功能

【自定形式】增加滑动验证码鉴定

【自定形式】 提升高效率,目录鉴定速度翻倍

【自定形式】自动检索网页Ajax点一下,全手动配备Ajax恳求超时時间,配备每日任务更便捷

【自定形式】改善优化算法,挑选网页原素更精确

【当地采集】采集速率总体提升10~30%,采集高效率大幅度提升

【任务列表】重新建立任务列表页面,大幅度提升特点主要表现,很多任务管理器已不卡屏

【任务列表】任务列表添加手动更新体制,可随时随地查询每日任务全新情况

Bug修复

修补云采集查询数据信息迟滞困局

修补采集错误报告 排版设计衰弱困局

修补「开启网页时侯出現错码」难题

修补拖放步骤后突然消散的困局

修补定时执行导下来、全手动进库专用工具自弹出出困局

修补备份時间种类数据信息错误困局

优采云采集器(信息采集工具) v7.2.2.12221官方版

采集交流 • 优采云 发表了文章 • 0 个评论 • 376 次浏览 • 2020-08-09 21:20

6. 监控各大地产相关网站,采集新房二手房最新行情;

7. 采集各大车辆网站具体的新车二手车信息;

8. 发现和搜集潜在顾客信息;

9. 采集行业网站的产品目录及产品信息;

10. 在各大电商平台之间同步商品信息,做到在一个平台发布,其他平台手动更新。

软件特色

任何人都可以使用

还在研究网页源代码和抓包工具吗?现在不用了,会上网才能采集,所见即所得的界面,可视化流程,无需懂技术,点点鼠标,2分钟即可快速入门。

任何网站都可以采集

不仅使用简单,而且功能强悍:点击,登陆,翻页,甚至识别验证码,当网页出错误,或者多套模版完全不一样的时侯,还可以依据不同情况做不同的处理。

云采集,关机也可以

配置好采集任务,就可以死机了,任务可以在云端执行,数量庞大的企业云,24*7不间断运行,再也不用害怕IP被封,网络中断了,还能顿时采集大量数据。

使用方式

先我们新建一个任务-->进入流程设计页面-->添加一个循环步骤到流程中-->选中循环步骤-->勾选上软件右方的URL 列表勾选框-->打开URL列表文本框-->将打算好的URL列表填写到文本框中

接下来往循环中推入一个打开网页的步骤-->选中打开网页步骤-->勾选上使用当前循环里的URL作为导航地址-->点击保存。系统会在界面下方的浏览器中打开循环中选中的URL对应的网页

。

到这儿,循环打开网页的流程就配置完成了,运行流程的时侯,系统会挨个的打开循环中设置的URL。最后我们不需要配置一个采集数据的步骤,这里就不在多讲,大家可以参考从入门到精通系列1:采集单个网页 这篇文章。下图就是最终和流程

下面是流程最终的运行结果

更新日志

V7.6.0(正式) 2019-01-04

主要体验改进

【自定义模式】新增JSON采集功能

【自定义模式】新增滑动验证码识别

【自定义模式】优化效率,列表辨识速率翻番

【自定义模式】自动辨识网页Ajax点击,自动配置Ajax超时时间,配置任务更方便

【自定义模式】改进算法,选择网页元素更精准

【本地采集】采集速度整体提高10~30%,采集效率急剧增强

【任务列表】重构任务列表界面,大幅提升性能表现,大量任务管理不再卡顿

【任务列表】任务列表加入手动刷新机制,可随时查看任务最新状态

Bug修补

修复云采集查看数据平缓问题

修复采集错误报告排版错乱问题

修复「打开网页时会出现乱码」问题

修复拖动流程后忽然消失的问题

修复定时导入、自动入库工具手动弹出问题

修复低格时间类型数据出错问题 查看全部

5. 采集最新最全的职场急聘信息;

6. 监控各大地产相关网站,采集新房二手房最新行情;

7. 采集各大车辆网站具体的新车二手车信息;

8. 发现和搜集潜在顾客信息;

9. 采集行业网站的产品目录及产品信息;

10. 在各大电商平台之间同步商品信息,做到在一个平台发布,其他平台手动更新。

软件特色

任何人都可以使用

还在研究网页源代码和抓包工具吗?现在不用了,会上网才能采集,所见即所得的界面,可视化流程,无需懂技术,点点鼠标,2分钟即可快速入门。

任何网站都可以采集

不仅使用简单,而且功能强悍:点击,登陆,翻页,甚至识别验证码,当网页出错误,或者多套模版完全不一样的时侯,还可以依据不同情况做不同的处理。

云采集,关机也可以

配置好采集任务,就可以死机了,任务可以在云端执行,数量庞大的企业云,24*7不间断运行,再也不用害怕IP被封,网络中断了,还能顿时采集大量数据。

使用方式

先我们新建一个任务-->进入流程设计页面-->添加一个循环步骤到流程中-->选中循环步骤-->勾选上软件右方的URL 列表勾选框-->打开URL列表文本框-->将打算好的URL列表填写到文本框中

接下来往循环中推入一个打开网页的步骤-->选中打开网页步骤-->勾选上使用当前循环里的URL作为导航地址-->点击保存。系统会在界面下方的浏览器中打开循环中选中的URL对应的网页

。

到这儿,循环打开网页的流程就配置完成了,运行流程的时侯,系统会挨个的打开循环中设置的URL。最后我们不需要配置一个采集数据的步骤,这里就不在多讲,大家可以参考从入门到精通系列1:采集单个网页 这篇文章。下图就是最终和流程

下面是流程最终的运行结果

更新日志

V7.6.0(正式) 2019-01-04

主要体验改进

【自定义模式】新增JSON采集功能

【自定义模式】新增滑动验证码识别

【自定义模式】优化效率,列表辨识速率翻番

【自定义模式】自动辨识网页Ajax点击,自动配置Ajax超时时间,配置任务更方便

【自定义模式】改进算法,选择网页元素更精准

【本地采集】采集速度整体提高10~30%,采集效率急剧增强

【任务列表】重构任务列表界面,大幅提升性能表现,大量任务管理不再卡顿

【任务列表】任务列表加入手动刷新机制,可随时查看任务最新状态

Bug修补

修复云采集查看数据平缓问题

修复采集错误报告排版错乱问题

修复「打开网页时会出现乱码」问题

修复拖动流程后忽然消失的问题

修复定时导入、自动入库工具手动弹出问题

修复低格时间类型数据出错问题

百度辨识原创文章算法的具体细节

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2020-08-09 21:18

一、搜索引擎为何要注重原创

1.1 采集泛滥化

来自百度的一项调查显示,超过80%的新闻和资讯等都在被人工转载或机器采集,从传统媒体的报纸到娱乐网站花边消息、从游戏攻略到产品评测,甚至高校图书馆发的催还通知都有站点在做机器采集。可以说,优质原创内容是被包围在采集的汪洋大海中之一粟,搜索引擎在海中淘粟,是既艰辛又具有挑战性的事情。

1.2 提高搜索用户体验

数字化增加了传播成本,工具化增加了采集成本,机器采集行为混淆内容来源增加内容质量。采集过程中,出于无意或有意,导致采集网页内容残缺不全,格式错乱或附加垃圾等问题层出不穷,这早已严重影响了搜索结果的质量和用户体验。搜索引擎注重原创的根本缘由是为了提升用户体验,这里讲的原创为优质原创内容。

1.3 鼓励原创作者和文章

转载和采集,分流了优质原创站点的流量,不再具属原创作者的名称,会直接影响到优质原创站长和作者的利润。长期看会影响原创者的积极性,不利于创新,不利于新的优质内容形成。鼓励优质原创,鼓励创新,给予原创站点和作者合理的流量,从而促使互联网内容的繁荣,理应是搜索引擎的一个重要任务。

二、采集很狡猾,识别原创太艰辛

2.1 采集冒充原创,篡改关键信息

当前,大量的网站批量采集原创内容后,用人工或机器的方式,篡改作者、发布时间和来源等关键信息,冒充原创。此类假扮原创是须要搜索引擎辨识下来给以适当调整的。

2.2 内容生成器,制造伪原创

利用手动文章生成器等工具,“独创”一篇文章,然后安一个吸引眼珠的标题,现在的成本也低得太,而且一定具有独创性。然而,原创是要具有社会共识价值的,而不是胡乱制造一篇根本不通的垃圾才能算做有价值的优质原创内容。内容其实奇特,但是不具社会共识价值,此类伪原创是搜索引擎须要重点辨识下来并给以严打的。

2.3 网页差异化,结构化信息提取困难

不同的站点结构化差别比较大,html标签的涵义和分布也不同,因此提取关键信息如标题、作者和时间的难易程度差异也比较大。做到既提得全,又提得准,还要最及时,在当前的英文互联网规模下实属不易,这部份将须要搜索引擎与站长配合好才能更顺畅的运行,站长们假如用更清晰的结构告知搜索引擎网页的布局,将使搜索引擎高效地提取原创相关的信息。

原创是环境问题,需要你们来共同维护,站长们多做原创,多推荐原创,百度将持续努力改进排序算法,鼓励原创内容,为原创作者、原创站点提供合理的排序和流量。 查看全部

据百度工程师称,百度原创辨识系统,在百度大数据的云计算平台上举办,能够快速实现对全部英文互联网网页的重复聚合和链接指向关系剖析。首先,通过内容相像程度来聚合采集和原创,将相像网页聚合在一起作为原创辨识的候选集合;其次,对原创候选集合,通过作者、发布时间、链接指向、用户评论、作者和站点的历史原创情况、转发轨迹等上百种诱因来辨识判别出原创网页;最后,通过价值剖析系统判定该原创内容的价值高低因而适当的指导最终排序。同时LEE表示,通过实验以及真实线上数据,百度原创辨识“起源”算法早已取得了一定的进展,在新闻、资讯等领域解决了绝大部分问题。下面简单介绍一下原创文章算法的具体细节。

一、搜索引擎为何要注重原创

1.1 采集泛滥化

来自百度的一项调查显示,超过80%的新闻和资讯等都在被人工转载或机器采集,从传统媒体的报纸到娱乐网站花边消息、从游戏攻略到产品评测,甚至高校图书馆发的催还通知都有站点在做机器采集。可以说,优质原创内容是被包围在采集的汪洋大海中之一粟,搜索引擎在海中淘粟,是既艰辛又具有挑战性的事情。

1.2 提高搜索用户体验

数字化增加了传播成本,工具化增加了采集成本,机器采集行为混淆内容来源增加内容质量。采集过程中,出于无意或有意,导致采集网页内容残缺不全,格式错乱或附加垃圾等问题层出不穷,这早已严重影响了搜索结果的质量和用户体验。搜索引擎注重原创的根本缘由是为了提升用户体验,这里讲的原创为优质原创内容。

1.3 鼓励原创作者和文章

转载和采集,分流了优质原创站点的流量,不再具属原创作者的名称,会直接影响到优质原创站长和作者的利润。长期看会影响原创者的积极性,不利于创新,不利于新的优质内容形成。鼓励优质原创,鼓励创新,给予原创站点和作者合理的流量,从而促使互联网内容的繁荣,理应是搜索引擎的一个重要任务。

二、采集很狡猾,识别原创太艰辛

2.1 采集冒充原创,篡改关键信息

当前,大量的网站批量采集原创内容后,用人工或机器的方式,篡改作者、发布时间和来源等关键信息,冒充原创。此类假扮原创是须要搜索引擎辨识下来给以适当调整的。

2.2 内容生成器,制造伪原创

利用手动文章生成器等工具,“独创”一篇文章,然后安一个吸引眼珠的标题,现在的成本也低得太,而且一定具有独创性。然而,原创是要具有社会共识价值的,而不是胡乱制造一篇根本不通的垃圾才能算做有价值的优质原创内容。内容其实奇特,但是不具社会共识价值,此类伪原创是搜索引擎须要重点辨识下来并给以严打的。

2.3 网页差异化,结构化信息提取困难

不同的站点结构化差别比较大,html标签的涵义和分布也不同,因此提取关键信息如标题、作者和时间的难易程度差异也比较大。做到既提得全,又提得准,还要最及时,在当前的英文互联网规模下实属不易,这部份将须要搜索引擎与站长配合好才能更顺畅的运行,站长们假如用更清晰的结构告知搜索引擎网页的布局,将使搜索引擎高效地提取原创相关的信息。

原创是环境问题,需要你们来共同维护,站长们多做原创,多推荐原创,百度将持续努力改进排序算法,鼓励原创内容,为原创作者、原创站点提供合理的排序和流量。

NLP技术在金融资管领域的落地实践

采集交流 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2020-08-09 14:36

本文的主要内容包括:

01

背景及技术构架

1. 非结构化数据快速下降

信息不对称是金融行业的本质特点与竞争焦点。如上图,是一张来自IDC的报告,表明近来几年全球新增的数据有80%来自非结构化数据。所以大量及时有效的信息分布在非结构化的文本数据中,如研报、新闻资讯、twitter 中,金融机构须要利用自然语言处理技术从中高效、准确地挖掘出结构化信息,从中获取前瞻的商业洞察。

我们团队运用迁移学习、少样本学习、无监督学习等人工智能领域最新思想和技术,已经建立起建立的自然语言处理技术构架,提供端到端的海量文本剖析和监控系统,帮助金融资管顾客跨越非结构化文本到结构化数据的鸿沟,进而辅助顾客进行快速的行业剖析、投资决策。

接下来我们看下NLP技术怎么嵌入到行业剖析和投资决策的:

2. 智能投研流程

智能化的投研流程包括:

最终这三个阶段产生了一个完整的从数据获取->数据处理->数据建模->逻辑推理的链条。这个链条构成了一个完全自动化、工业化、24小时不停机的智能化投研系统。

为了实现智能投研系统的目标,我们来看下自然语言处理技术的构架是什么样的:

3. 自然语言处理技术构架

我们的自然语言处理技术构架分为:应用层、组件层和意料层。

应用层:直接对接业务逻辑,目前熵简科技30 端到端文本剖析系统,服务于20 金融资管和咨询领域的机构,累计30 业务应用场景。

组件层:提供自然语言处理中的基础算法组件,包括智能动词组件、词性标明、依存句型剖析、词向量、语义相似度、命名实体辨识组件。

语料层:语料层提供基础层中各算法组件、应用层中各算法模块的训练和测试语料。

通过这些方法建立的自然语言处理构架有两个显而易见的益处:

接下来介绍两个比较典型的应用场景:招投标文本剖析系统和金融舆情监控系统。

其中:

通过这两个典型的金融应用场景,来分享我们在实际实践的过程中遇见的一些问题和解决思路。

02

端到端的招投标文本剖析系统

什么是招投标数据?

公司在采购软硬件时,一般会发布一个招标公告,供应商听到公告后,撰写并递交自己的投标书,甲方评估后发布中标公告,告知你们谁中标。

招投标数据为何重要?

对于一家上市公司而言,如果主营业务是toB的模式,我们可以通过招投标的数据来预测公司的营业收入,比如一家公司中标了一个大单,我们可以通过招投标数据提早预知。

如上图的案例:

左边是一家公司披露的中标公告,中标金额6.5亿,公告的发布时间是17年的10月17日;中间是我们在互联网公开数据中采集到的中标公告,无论是项目名称、中标单位、中标金额,都和右边的内容是一致的,唯一不同的是时间,我们采集到数据的时间比公司披露的时间,早了16天,这就可以帮助我们在获得关键信息上占有优势。

1. 招投标大数据剖析系统技术构架图

为了实现全网的招投标数据监控,我们研制了端到端的智能化招投标文本剖析系统,实现了千万级招投标文本的流式处理。主要包括:智能化网页抽取系统、招投标文本剖析服务和数据展示。 首先我们的招投标文本剖析系统会从外部海量的招投标网站上采集最原创的招投标标书,接下来用招投标文本剖析服务对标书进行结构化的处理,把其中最关键的信息提取下来,最终借助数据展示、分析面板对数据进行二次的剖析和展示,方便业务人员使用。

下面为你们介绍其中最核心的两个算法组件,智能网页抽取系统和招投标信息抽取模型。

2. 智能网页抽取系统

常规的数据采集步骤包括:

由于须要采集的网站非常多,需要大量的人力,导致成本十分高,效率低下。所以我们须要一套智能化的信息抽取引擎。可以从海量网页类文本数据中自动化地抽取出特定区域、特定用途的文本片断,即从招投标网页数据中抽取标书标题、标书正文。

难点:

网页抽取的物理模型:

每一个网页可以等价成带有各种信息的树,新闻正文的文本、图片、超链接分布在树上的各个黑色节点,因此须要剔除无关节点,再根据节点位置信息进行序列化,这里的难点是怎样高精度的剔除无关节点。

构建 Tag embedding:

我们首先要解决的问题是把网页中的html编码的标签和属性进行数值化的表示。针对这个问题,受到 word2vec 的 Skip-gram 思想启发,我们提出了 tag embedding 的算法模型,目标函数如上。其关键思想是用当前节点的 tag 去预测父节点的 tag 和子节点的 tag。

Tag embedding模型的特征:

基于全联接网路的二分类器:

有了Tag embedding以后,我们进一步提出了基于三层前馈神经网络的二分类器,主要拿来判定节点是否保留。

如上图,输入特点主要包括:父节点的标签信息、子节点的标签信息、当前节点的标签信息,以及当前节点在其它方面的特点,比如当前节点收录文本的宽度是多少、超链接的数量是多少。

模型性能:

使用相对简单的三层前馈神经网络的缘由,主要是:

同时,这种模型的思想还可以推广到其它任务:

目前,我们早已实现了海量招投标文本的采集,接下来我们须要把文本数据进行结构化,得到我们想要的数据数组。

3. 招投标信息抽取模型

① 提取目标:

我们招投标信息提取模型的目标是从海量的招投标标书中,提取关键信息,如招标单位、中标单位、中标金额、产品类型 等等。

这其中的难点是招投标文件完全由撰写人来制定,没有规范统一的格式,无法通过统一化的规则处理:

② 特定实体类抽取方案:

我们把这个任务具象以后,跟命名实体识别十分类似,在我们的处理框架中,把它定义为特定实体类抽取,其结构包括:预处理层、实体提取层、实体判断层、选举决策层。这里重点介绍下实体提取层和实体判断层:

通过这些两阶段处理,多模型融合。第一阶段不依赖于领域语料,采用通用命名实体辨识语料训练。第二阶段在少量招投标专业语料训练即可。同时实现了高召回和高精度。

接下来详尽介绍下这两阶段中的核心模块,通用命名实体辨识和CNN判定器。

③ 基于改进Transformer的命名实体辨识

对于通用命名实体辨识组件,我们团队先后迭代了几个版本,目前最新的方案参考了复旦大学邱老师团队在19年提出的模型。在这个模型中我们主要是以改进的Transformer模型为主要的特点提取器,再结合CRF层,引入全局约束信息来实现命名实体辨识任务。左图为整个方案的结构图,右图为原生的Transformer结构,用来做对比。

我们的方案相对于原生的Transformer主要做了两个方面改进:

具体的实验疗效如下:

④ 基于卷积神经网络的实体裁定

这里我们采用TextCNN作为核心组件,整个网路由Embedding层、卷积层和前向网路层构成。

招投标信息抽取模型的测试结果:

我们在5000条招投标数据上的测试结果如上,简单总结如下:

4. 端到端招投标大数据剖析系统

基于上面的成果,我们可以建立起招投标大数据剖析系统,这一系统收录了从海量标书智能化采集、文本数据结构化到辅助投资决策的全流程,实现千万级文本数据的采集和快速剖析,帮助顾客预测跟踪 toB行业与公司的发展状况及竞争格局。

5. 招投标大数据剖析系统部份功能展示

这里展示了怎样运用招投标数据对海康威视进行公司发展状况剖析和业绩预测。比如,通过历史数据回测,我们发觉中标数据与公司定期公布的季度收入高度相关,因此这一数据可以作为未来业绩预测的一项重要参考基准。另外,利用地域剖析,我们可以了解到海康威视在不同地区的竞争格局和产值状况,从而更深入地了解这家公司的经营状况。

6. 小节

03

少样本场景下的金融舆情监控系统

1. 金融舆情监控系统

在金融领域,存在两类机构,一类是卖方,一类是买方。买方通常直接操作股票的买卖,如公募基金、私募基金等;卖方主要进行股票的剖析和研究,为卖方提供咨询和建议,主要包括券商和独立的研究机构等。通常一家卖方机构,往往会对接多家买方机构为其服务。我们晓得,微信已然成为了一个工作平台,因此微信群成了买方服务的重要场景,一个分析师常常会有几十个买方服务群,每时每刻都可能收到来自那些群的信息轰炸。这一场景主要面临的疼点有:

针对那些疼点,我们提出了金融舆情监控系统的解决方案,可以做到:

金融舆情监控系统的流程:

首先把微信群中的信息,如文本信息、链接、文件等抽取成公司、行业、机构等3类标签,然后进行业务分类,目前有4个大类,11个小类,同时我们的系统都会把结构化的文本提取下来,如文章作者、会议时间等等。这样就可以做好多有价值的应用:如热点追踪、分类汇总、报告检索、事件发觉、投研月历等等。

2. 金融舆情监控系统技术构架图

金融舆情监控系统技术构架包括3层服务:金融舆情文本剖析服务、数据清洗服务、展示服务。

其中,金融舆情文本剖析服务最关键的三个组件是:信息类型分类、一级行业分类和特定实体提取。

3. 少样本窘境

在实践中,很多与金融领域内的问题都与特定的场景相关,金融公司一般面临的少样本窘境主要包括:

针对少样本窘境,常用的路径有:迁移学习、数据提高、无监督学习、半监督学习。接下来,我们通过介绍金融舆情中两类主要算法组件的实现方法,来分享我们解决少样本问题的思路。

4. 微信信息分类模型

微信信息分类模型的目标:对微信群里的文本信息、文件、链接消息等消息进行分类,分为公司深度、公司点评、行业深度、行业点评、宏观策略报告、固收报告、调研纪要、会议纪要、调研约请、会议约请及其他,共11个类别。

整个模型是以TextCNN网路和Fasttext作为两个基本模型,再通过XGBoost将两个模型集成上去。这里用到的TextCNN网路与后面的招投标网路基本是一致的,除了在Embedding层,我们把位置向量除去了。其益处有:

5. 文本提高技术

文本提高技术是一类低成本的数据杠杆,可以在不引入新数据下,有效撬动模型性能,尤其在少样本场景下。

常用的场景包括:

总的来说,由于文本提高技术可以提升模型的鲁棒性,除非数据量十分丰富,通常可以采用文本提高技术进行尝试,一般都有正向的疗效。

典型的文本提高技术有:

关于文本提高技术的详尽介绍,可参考我们团队之前的一篇文章:

6. 数据提高的实验结果

样本集情况:

实验结果见下图,总结如下:

最终的实验结果见上图,通过本文提高技术以及一些其它方式,我们基本解决了少样本问题。

文本提高技术为何可以在没有引入额外数据的情况下,起到如此好的疗效? 查看全部

在数字化浪潮的大背景下,金融资管行业的先行者正在积极探求将人工智能、大数据等先进技术用于建立面向未来的智能化投资研究平台。本文将从金融资管领域对于数据智能的需求入手,详细介绍自然语言处理技术在金融资管领域的典型落地实践。针对海量文本的信息挖掘场景,我们借助Transformer、CNN等最新研究成果以及团队自研的 tag2vec 等技术,构建了端到端的文本大数据剖析系统,收录了从海量文本智能化采集、文本数据结构化到辅助投资决策的全流程,实现千万级文本数据的采集和快速剖析,进而帮助顾客进行快速精准的行业剖析和投资决策。针对少样本下的文本数据监控场景,我们基于熵简NLP技术中台所提供的分层技术构架,利用文本提高技术、少样本学习、迁移学习等思想,在少样本场景下打造高效能的金融舆情监控系统,帮助金融资管顾客实现从数据负债到数据资产的跨越,从中获取前瞻的商业洞察,赢得先机。

本文的主要内容包括:

01

背景及技术构架

1. 非结构化数据快速下降

信息不对称是金融行业的本质特点与竞争焦点。如上图,是一张来自IDC的报告,表明近来几年全球新增的数据有80%来自非结构化数据。所以大量及时有效的信息分布在非结构化的文本数据中,如研报、新闻资讯、twitter 中,金融机构须要利用自然语言处理技术从中高效、准确地挖掘出结构化信息,从中获取前瞻的商业洞察。

我们团队运用迁移学习、少样本学习、无监督学习等人工智能领域最新思想和技术,已经建立起建立的自然语言处理技术构架,提供端到端的海量文本剖析和监控系统,帮助金融资管顾客跨越非结构化文本到结构化数据的鸿沟,进而辅助顾客进行快速的行业剖析、投资决策。

接下来我们看下NLP技术怎么嵌入到行业剖析和投资决策的:

2. 智能投研流程

智能化的投研流程包括:

最终这三个阶段产生了一个完整的从数据获取->数据处理->数据建模->逻辑推理的链条。这个链条构成了一个完全自动化、工业化、24小时不停机的智能化投研系统。

为了实现智能投研系统的目标,我们来看下自然语言处理技术的构架是什么样的:

3. 自然语言处理技术构架

我们的自然语言处理技术构架分为:应用层、组件层和意料层。

应用层:直接对接业务逻辑,目前熵简科技30 端到端文本剖析系统,服务于20 金融资管和咨询领域的机构,累计30 业务应用场景。

组件层:提供自然语言处理中的基础算法组件,包括智能动词组件、词性标明、依存句型剖析、词向量、语义相似度、命名实体辨识组件。

语料层:语料层提供基础层中各算法组件、应用层中各算法模块的训练和测试语料。

通过这些方法建立的自然语言处理构架有两个显而易见的益处:

接下来介绍两个比较典型的应用场景:招投标文本剖析系统和金融舆情监控系统。

其中:

通过这两个典型的金融应用场景,来分享我们在实际实践的过程中遇见的一些问题和解决思路。

02

端到端的招投标文本剖析系统

什么是招投标数据?

公司在采购软硬件时,一般会发布一个招标公告,供应商听到公告后,撰写并递交自己的投标书,甲方评估后发布中标公告,告知你们谁中标。

招投标数据为何重要?

对于一家上市公司而言,如果主营业务是toB的模式,我们可以通过招投标的数据来预测公司的营业收入,比如一家公司中标了一个大单,我们可以通过招投标数据提早预知。

如上图的案例:

左边是一家公司披露的中标公告,中标金额6.5亿,公告的发布时间是17年的10月17日;中间是我们在互联网公开数据中采集到的中标公告,无论是项目名称、中标单位、中标金额,都和右边的内容是一致的,唯一不同的是时间,我们采集到数据的时间比公司披露的时间,早了16天,这就可以帮助我们在获得关键信息上占有优势。

1. 招投标大数据剖析系统技术构架图

为了实现全网的招投标数据监控,我们研制了端到端的智能化招投标文本剖析系统,实现了千万级招投标文本的流式处理。主要包括:智能化网页抽取系统、招投标文本剖析服务和数据展示。 首先我们的招投标文本剖析系统会从外部海量的招投标网站上采集最原创的招投标标书,接下来用招投标文本剖析服务对标书进行结构化的处理,把其中最关键的信息提取下来,最终借助数据展示、分析面板对数据进行二次的剖析和展示,方便业务人员使用。

下面为你们介绍其中最核心的两个算法组件,智能网页抽取系统和招投标信息抽取模型。

2. 智能网页抽取系统

常规的数据采集步骤包括:

由于须要采集的网站非常多,需要大量的人力,导致成本十分高,效率低下。所以我们须要一套智能化的信息抽取引擎。可以从海量网页类文本数据中自动化地抽取出特定区域、特定用途的文本片断,即从招投标网页数据中抽取标书标题、标书正文。

难点:

网页抽取的物理模型:

每一个网页可以等价成带有各种信息的树,新闻正文的文本、图片、超链接分布在树上的各个黑色节点,因此须要剔除无关节点,再根据节点位置信息进行序列化,这里的难点是怎样高精度的剔除无关节点。

构建 Tag embedding:

我们首先要解决的问题是把网页中的html编码的标签和属性进行数值化的表示。针对这个问题,受到 word2vec 的 Skip-gram 思想启发,我们提出了 tag embedding 的算法模型,目标函数如上。其关键思想是用当前节点的 tag 去预测父节点的 tag 和子节点的 tag。

Tag embedding模型的特征:

基于全联接网路的二分类器:

有了Tag embedding以后,我们进一步提出了基于三层前馈神经网络的二分类器,主要拿来判定节点是否保留。

如上图,输入特点主要包括:父节点的标签信息、子节点的标签信息、当前节点的标签信息,以及当前节点在其它方面的特点,比如当前节点收录文本的宽度是多少、超链接的数量是多少。

模型性能:

使用相对简单的三层前馈神经网络的缘由,主要是:

同时,这种模型的思想还可以推广到其它任务:

目前,我们早已实现了海量招投标文本的采集,接下来我们须要把文本数据进行结构化,得到我们想要的数据数组。

3. 招投标信息抽取模型

① 提取目标:

我们招投标信息提取模型的目标是从海量的招投标标书中,提取关键信息,如招标单位、中标单位、中标金额、产品类型 等等。

这其中的难点是招投标文件完全由撰写人来制定,没有规范统一的格式,无法通过统一化的规则处理:

② 特定实体类抽取方案:

我们把这个任务具象以后,跟命名实体识别十分类似,在我们的处理框架中,把它定义为特定实体类抽取,其结构包括:预处理层、实体提取层、实体判断层、选举决策层。这里重点介绍下实体提取层和实体判断层:

通过这些两阶段处理,多模型融合。第一阶段不依赖于领域语料,采用通用命名实体辨识语料训练。第二阶段在少量招投标专业语料训练即可。同时实现了高召回和高精度。

接下来详尽介绍下这两阶段中的核心模块,通用命名实体辨识和CNN判定器。

③ 基于改进Transformer的命名实体辨识

对于通用命名实体辨识组件,我们团队先后迭代了几个版本,目前最新的方案参考了复旦大学邱老师团队在19年提出的模型。在这个模型中我们主要是以改进的Transformer模型为主要的特点提取器,再结合CRF层,引入全局约束信息来实现命名实体辨识任务。左图为整个方案的结构图,右图为原生的Transformer结构,用来做对比。

我们的方案相对于原生的Transformer主要做了两个方面改进:

具体的实验疗效如下:

④ 基于卷积神经网络的实体裁定

这里我们采用TextCNN作为核心组件,整个网路由Embedding层、卷积层和前向网路层构成。

招投标信息抽取模型的测试结果:

我们在5000条招投标数据上的测试结果如上,简单总结如下:

4. 端到端招投标大数据剖析系统

基于上面的成果,我们可以建立起招投标大数据剖析系统,这一系统收录了从海量标书智能化采集、文本数据结构化到辅助投资决策的全流程,实现千万级文本数据的采集和快速剖析,帮助顾客预测跟踪 toB行业与公司的发展状况及竞争格局。

5. 招投标大数据剖析系统部份功能展示

这里展示了怎样运用招投标数据对海康威视进行公司发展状况剖析和业绩预测。比如,通过历史数据回测,我们发觉中标数据与公司定期公布的季度收入高度相关,因此这一数据可以作为未来业绩预测的一项重要参考基准。另外,利用地域剖析,我们可以了解到海康威视在不同地区的竞争格局和产值状况,从而更深入地了解这家公司的经营状况。

6. 小节

03

少样本场景下的金融舆情监控系统

1. 金融舆情监控系统

在金融领域,存在两类机构,一类是卖方,一类是买方。买方通常直接操作股票的买卖,如公募基金、私募基金等;卖方主要进行股票的剖析和研究,为卖方提供咨询和建议,主要包括券商和独立的研究机构等。通常一家卖方机构,往往会对接多家买方机构为其服务。我们晓得,微信已然成为了一个工作平台,因此微信群成了买方服务的重要场景,一个分析师常常会有几十个买方服务群,每时每刻都可能收到来自那些群的信息轰炸。这一场景主要面临的疼点有:

针对那些疼点,我们提出了金融舆情监控系统的解决方案,可以做到:

金融舆情监控系统的流程:

首先把微信群中的信息,如文本信息、链接、文件等抽取成公司、行业、机构等3类标签,然后进行业务分类,目前有4个大类,11个小类,同时我们的系统都会把结构化的文本提取下来,如文章作者、会议时间等等。这样就可以做好多有价值的应用:如热点追踪、分类汇总、报告检索、事件发觉、投研月历等等。

2. 金融舆情监控系统技术构架图

金融舆情监控系统技术构架包括3层服务:金融舆情文本剖析服务、数据清洗服务、展示服务。

其中,金融舆情文本剖析服务最关键的三个组件是:信息类型分类、一级行业分类和特定实体提取。

3. 少样本窘境

在实践中,很多与金融领域内的问题都与特定的场景相关,金融公司一般面临的少样本窘境主要包括:

针对少样本窘境,常用的路径有:迁移学习、数据提高、无监督学习、半监督学习。接下来,我们通过介绍金融舆情中两类主要算法组件的实现方法,来分享我们解决少样本问题的思路。

4. 微信信息分类模型

微信信息分类模型的目标:对微信群里的文本信息、文件、链接消息等消息进行分类,分为公司深度、公司点评、行业深度、行业点评、宏观策略报告、固收报告、调研纪要、会议纪要、调研约请、会议约请及其他,共11个类别。

整个模型是以TextCNN网路和Fasttext作为两个基本模型,再通过XGBoost将两个模型集成上去。这里用到的TextCNN网路与后面的招投标网路基本是一致的,除了在Embedding层,我们把位置向量除去了。其益处有:

5. 文本提高技术

文本提高技术是一类低成本的数据杠杆,可以在不引入新数据下,有效撬动模型性能,尤其在少样本场景下。

常用的场景包括:

总的来说,由于文本提高技术可以提升模型的鲁棒性,除非数据量十分丰富,通常可以采用文本提高技术进行尝试,一般都有正向的疗效。

典型的文本提高技术有:

关于文本提高技术的详尽介绍,可参考我们团队之前的一篇文章:

6. 数据提高的实验结果

样本集情况:

实验结果见下图,总结如下:

最终的实验结果见上图,通过本文提高技术以及一些其它方式,我们基本解决了少样本问题。

文本提高技术为何可以在没有引入额外数据的情况下,起到如此好的疗效?

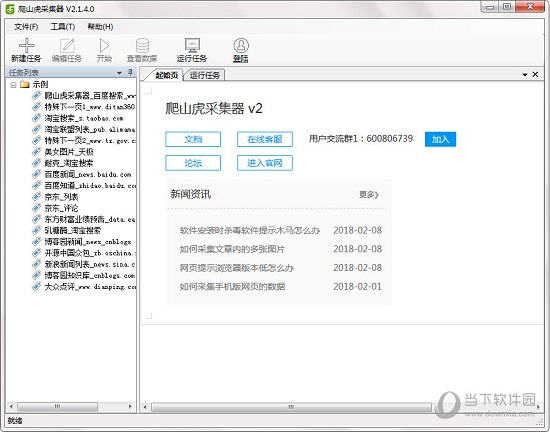

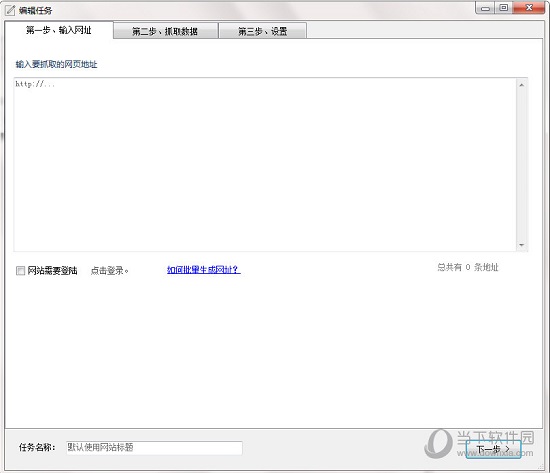

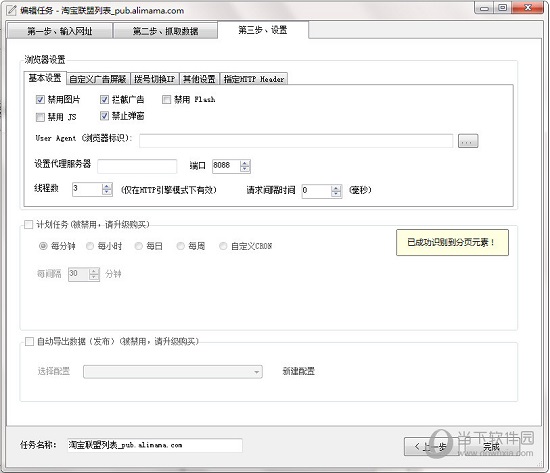

优采云采集器 V2.1.8.0 官方版

采集交流 • 优采云 发表了文章 • 0 个评论 • 569 次浏览 • 2020-08-09 09:18

【软件特色】

一键提取数据

简单易学,通过可视化界面,鼠标点击即可抓取数据

快速高效

内置一套高速浏览器内核,加上HTTP引擎模式,实现快速采集数据

适用各类网站

能够采集互联网99%的网站,包括单页应用Ajax加载等等动态类型网站

【功能介绍】

向导模式

简单易用,轻松通过滑鼠点击手动生成

脚本定时运行

可依照计划定时运行,无需人工

独创高速内核

自研的浏览器内核,速度飞快,远超对手

智能辨识

对于网页中的列表、表单结构(多选框下拉列表等)能够智能辨识

广告屏蔽

定制的广告屏蔽模块,兼容AdblockPlus句型,可添加自定义规则

多种数据导入

支持Txt 、Excel、MySQL、SQLServer、SQlite、Access、网站等

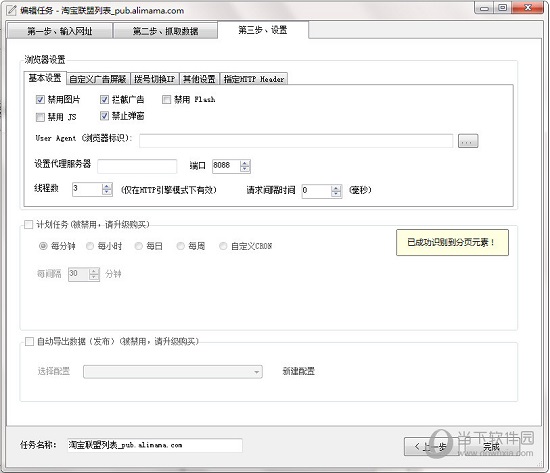

【使用流程】

输入采集网址

打开软件,新建任务,输入须要采集的网站地址。

智能剖析,全程自动化提取数据

进入到第二步后,优采云采集器全手动智能剖析网页,并且从中提取出列表数据。

导出数据到表格、数据库、网站等

运行任务,将采集到的数据导入为Csv、Excel以及各类数据库,支持api导入。

【常见问题】

问:如何过滤列表中的前N个数据?

1、有时我们须要对采集到的列表进行过滤,比如过滤掉第一组数据(在采集表格时,过滤掉表格列名)

2、点击列表模式菜单中的,设置列表xpath

问:如何抓包获取Cookie,并且自动设置?

1、首先,使用谷歌浏览器打开要采集的网站,并且登入。

2、然后按下 F12,会出现开发者工具,选择 Network

3、然后按下F5,刷新下页面, 选择其中一个恳求。

4、复制完成后,在优采云采集器中,编辑任务,进入第三步,指定HTTP Header。

【更新日志】

V2.1.8.0

1、增加插件功能

2、增加导入 txt (一条保存为一个文件)

3、多值连接符支持换行符

4、修改数据处理的文本映射(支持查找替换)

5、修复登录时的DNS问题

6、修复图片下载问题

7、修复 json 一些问题 查看全部

优采云采集器是一款新一代智能化的网页采集工具,智能剖析、可视化界面,一键采集无需编程,支持手动生成采集脚本,可以采集互联网99%的网站。软件简单易学,通过智能算法+可视化界面,随心所欲,抓取自己想到的数据。只要轻松点击滑鼠,就能采集网页上的数据。

【软件特色】

一键提取数据

简单易学,通过可视化界面,鼠标点击即可抓取数据

快速高效

内置一套高速浏览器内核,加上HTTP引擎模式,实现快速采集数据

适用各类网站

能够采集互联网99%的网站,包括单页应用Ajax加载等等动态类型网站

【功能介绍】

向导模式

简单易用,轻松通过滑鼠点击手动生成

脚本定时运行

可依照计划定时运行,无需人工

独创高速内核

自研的浏览器内核,速度飞快,远超对手

智能辨识

对于网页中的列表、表单结构(多选框下拉列表等)能够智能辨识

广告屏蔽

定制的广告屏蔽模块,兼容AdblockPlus句型,可添加自定义规则

多种数据导入

支持Txt 、Excel、MySQL、SQLServer、SQlite、Access、网站等

【使用流程】

输入采集网址

打开软件,新建任务,输入须要采集的网站地址。

智能剖析,全程自动化提取数据

进入到第二步后,优采云采集器全手动智能剖析网页,并且从中提取出列表数据。

导出数据到表格、数据库、网站等

运行任务,将采集到的数据导入为Csv、Excel以及各类数据库,支持api导入。

【常见问题】

问:如何过滤列表中的前N个数据?

1、有时我们须要对采集到的列表进行过滤,比如过滤掉第一组数据(在采集表格时,过滤掉表格列名)

2、点击列表模式菜单中的,设置列表xpath

问:如何抓包获取Cookie,并且自动设置?

1、首先,使用谷歌浏览器打开要采集的网站,并且登入。

2、然后按下 F12,会出现开发者工具,选择 Network

3、然后按下F5,刷新下页面, 选择其中一个恳求。

4、复制完成后,在优采云采集器中,编辑任务,进入第三步,指定HTTP Header。

【更新日志】

V2.1.8.0

1、增加插件功能

2、增加导入 txt (一条保存为一个文件)

3、多值连接符支持换行符

4、修改数据处理的文本映射(支持查找替换)

5、修复登录时的DNS问题

6、修复图片下载问题

7、修复 json 一些问题

Breeze Collector v2020.06.06正式安装版本

采集交流 • 优采云 发表了文章 • 0 个评论 • 171 次浏览 • 2020-08-08 21:39

软件简介:

微风采集器是一种无需任何编程基础即可使用的采集软件. 微风采集器使用预定义的模板. 不同的模板可以执行不同的任务,因此用户可以在不知道任何代码的情况下采集所需的内容. 数据. 用户只需要选择相应的模板即可.

软件功能:

无需掌握任何编程技能,无需了解任何代码

基于强大的脚本引擎,可以快速自定义

根据您的需要选择一个模板并直接采集,这既简单又快速.

无需绑定计算机即可随意使用计算机

使用方法:

添加试用模板:

1. 您刚添加的模板将自动出现在模板下拉框中. 您以后可以使用它,只需在模板选择列表中选择它即可.

2. 打开软件,默认为采集标签. 在“选择模板”下拉框下方,单击“添加模板”.

3. 在弹出的模板选择页面中,单击模板以查看模板和简介,然后加入试用.

添加后,单击页面底部的“已选择”按钮.

4. 有关特定模板的用法,请参考教程索引页面.

注意:

禁用IPV6

在控制面板中打开一次

勾选IPV6,然后单击“确定”.

403错误的详细说明

1. 403禁止是什么意思?

403 Forbidden是HTTP协议中的状态码(状态码). 可以简单地理解为无权访问该站点. 此状态指示服务器理解请求但拒绝执行任务,并且不应将请求重新发送到服务器. 当HTTP请求方法不是“ HEAD”并且服务器希望让客户端知道为什么它没有权限时,服务器应在返回的信息中描述拒绝的原因. 如果服务器不想提供任何反馈信息,则服务器可以使用404 Not Found代替403 Forbidden.

两个. 403错误代码分类简介

403.1

403.1错误是由禁止“执行”访问引起的. 如果尝试从目录执行CGI,ISAPI或其他可执行程序,但是目录不允许执行该程序,则会发生此错误.

403.2

403.2错误是由禁止“读取”访问引起的. 造成此错误的原因是,没有可用的默认网页,并且该目录未启用目录浏览,或者要显示的HTML页面所在的目录仅标记有“可执行”或“脚本”权限.

403.3

403.3错误是由禁止“写”访问引起的. 尝试将文件上传到目录或修改目录中的文件时发生此错误,但是该目录不允许“写”访问.

403.4

403.4错误是由SSL要求引起的. 您必须在要查看的网页地址中使用“ https”.

403.5

403.5错误是由需要使用128位加密算法的Web浏览器引起的. 如果您的浏览器不支持128位加密算法,则会发生此错误. 您可以连接到Microsoft网站以升级浏览器.

403.6

403.6错误是由IP地址拒绝引起的. 如果服务器具有无法访问该站点的IP地址列表,并且您正在使用的IP地址在列表中,则您将返回此错误消息.

403.7

403.7错误是因为需要客户端证书. 当需要访问的资源要求浏览器具有服务器可以识别的安全套接字层(SSL)客户端证书时,将返回此错误.

403.8

403.8错误是由禁止站点访问引起的. 如果服务器具有无法访问的DNS名称列表,并且您使用的DNS名称在列表中,则将返回此信息. 请注意403.6和403.8错误之间的区别.

403.9

403.9错误是由过多的已连接用户引起的. 当Web服务器由于流量过多而无法处理请求时,将返回此错误.

403.10

403.10错误是由无效配置引起的错误. 当您尝试从目录执行CGI,ISAPI或其他可执行程序时,将返回此错误,但是该目录不允许执行该程序.

403.11

403.11错误是由于密码更改导致无法访问该页面.

403.12

403.12错误是由映射器拒绝访问引起的. 要查看的网页需要有效的客户端证书,并且当您的客户端证书映射没有访问该网站的权限时,将返回映射器拒绝访问的错误.

403.13

403.13错误是由以下事实引起的: 要查看的网页所使用的客户端证书要求使用有效的客户端证书已被吊销,或者无法确定证书是否已吊销.

403.14

403.14错误Web服务器配置为不列出此目录的内容,而是拒绝目录列表.

403.15

403.15错误是由过多的客户端访问权限引起的. 服务器超出其客户端访问权限限制时,将返回此错误.

403.16

403.16错误是由不可信或无效的客户端证书引起的.

403.17

403.17错误是由于客户端证书已过期或无效而引起的.

三,403错误的主要原因如下:

1. 您的IP已列入黑名单.

2. 您在一定时间内(通常通过使用采集程序)访问了该网站太多,并且防火墙拒绝了您的访问.

3. 网站的域名已解析为该空间,但该空间未与此域名绑定.

4. 您的Web脚本文件在当前目录中没有执行权限.

5. 在不允许写入/创建文件的目录中执行了文件创建/写入操作. 查看全部

微风采集器是一种简单实用的采集工具软件. 它不需要复杂的代码或主编程技术. 该操作简单易用. 用户只需要选择相应的模板即可采集所需的数据. 欢迎有需要的朋友下载和体验.

软件简介:

微风采集器是一种无需任何编程基础即可使用的采集软件. 微风采集器使用预定义的模板. 不同的模板可以执行不同的任务,因此用户可以在不知道任何代码的情况下采集所需的内容. 数据. 用户只需要选择相应的模板即可.

软件功能:

无需掌握任何编程技能,无需了解任何代码

基于强大的脚本引擎,可以快速自定义

根据您的需要选择一个模板并直接采集,这既简单又快速.

无需绑定计算机即可随意使用计算机

使用方法:

添加试用模板:

1. 您刚添加的模板将自动出现在模板下拉框中. 您以后可以使用它,只需在模板选择列表中选择它即可.

2. 打开软件,默认为采集标签. 在“选择模板”下拉框下方,单击“添加模板”.

3. 在弹出的模板选择页面中,单击模板以查看模板和简介,然后加入试用.

添加后,单击页面底部的“已选择”按钮.

4. 有关特定模板的用法,请参考教程索引页面.

注意:

禁用IPV6

在控制面板中打开一次

勾选IPV6,然后单击“确定”.

403错误的详细说明

1. 403禁止是什么意思?

403 Forbidden是HTTP协议中的状态码(状态码). 可以简单地理解为无权访问该站点. 此状态指示服务器理解请求但拒绝执行任务,并且不应将请求重新发送到服务器. 当HTTP请求方法不是“ HEAD”并且服务器希望让客户端知道为什么它没有权限时,服务器应在返回的信息中描述拒绝的原因. 如果服务器不想提供任何反馈信息,则服务器可以使用404 Not Found代替403 Forbidden.

两个. 403错误代码分类简介

403.1

403.1错误是由禁止“执行”访问引起的. 如果尝试从目录执行CGI,ISAPI或其他可执行程序,但是目录不允许执行该程序,则会发生此错误.

403.2

403.2错误是由禁止“读取”访问引起的. 造成此错误的原因是,没有可用的默认网页,并且该目录未启用目录浏览,或者要显示的HTML页面所在的目录仅标记有“可执行”或“脚本”权限.

403.3

403.3错误是由禁止“写”访问引起的. 尝试将文件上传到目录或修改目录中的文件时发生此错误,但是该目录不允许“写”访问.

403.4

403.4错误是由SSL要求引起的. 您必须在要查看的网页地址中使用“ https”.

403.5

403.5错误是由需要使用128位加密算法的Web浏览器引起的. 如果您的浏览器不支持128位加密算法,则会发生此错误. 您可以连接到Microsoft网站以升级浏览器.

403.6

403.6错误是由IP地址拒绝引起的. 如果服务器具有无法访问该站点的IP地址列表,并且您正在使用的IP地址在列表中,则您将返回此错误消息.

403.7

403.7错误是因为需要客户端证书. 当需要访问的资源要求浏览器具有服务器可以识别的安全套接字层(SSL)客户端证书时,将返回此错误.

403.8

403.8错误是由禁止站点访问引起的. 如果服务器具有无法访问的DNS名称列表,并且您使用的DNS名称在列表中,则将返回此信息. 请注意403.6和403.8错误之间的区别.

403.9

403.9错误是由过多的已连接用户引起的. 当Web服务器由于流量过多而无法处理请求时,将返回此错误.

403.10

403.10错误是由无效配置引起的错误. 当您尝试从目录执行CGI,ISAPI或其他可执行程序时,将返回此错误,但是该目录不允许执行该程序.

403.11

403.11错误是由于密码更改导致无法访问该页面.

403.12

403.12错误是由映射器拒绝访问引起的. 要查看的网页需要有效的客户端证书,并且当您的客户端证书映射没有访问该网站的权限时,将返回映射器拒绝访问的错误.

403.13

403.13错误是由以下事实引起的: 要查看的网页所使用的客户端证书要求使用有效的客户端证书已被吊销,或者无法确定证书是否已吊销.

403.14

403.14错误Web服务器配置为不列出此目录的内容,而是拒绝目录列表.

403.15

403.15错误是由过多的客户端访问权限引起的. 服务器超出其客户端访问权限限制时,将返回此错误.

403.16

403.16错误是由不可信或无效的客户端证书引起的.

403.17

403.17错误是由于客户端证书已过期或无效而引起的.

三,403错误的主要原因如下:

1. 您的IP已列入黑名单.

2. 您在一定时间内(通常通过使用采集程序)访问了该网站太多,并且防火墙拒绝了您的访问.

3. 网站的域名已解析为该空间,但该空间未与此域名绑定.

4. 您的Web脚本文件在当前目录中没有执行权限.

5. 在不允许写入/创建文件的目录中执行了文件创建/写入操作.

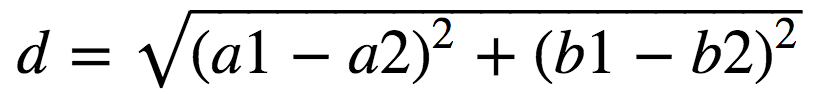

机器学习-识别手写字母的kNN算法

采集交流 • 优采云 发表了文章 • 0 个评论 • 431 次浏览 • 2020-08-08 20:07

kNN算法和相关的Python模块介绍,字母图像特征提取,kNN算法和kNN算法分析

I. kNN算法简介

K最近邻(kNN,k-NearestNeighbor)分类算法是机器学习算法中最简单的方法之一. 所谓的K个最近邻居是指k个最近邻居,这意味着每个样本都可以由其最近的k个邻居表示. 我们将样本分为训练样本和测试样本. 为了对测试样本t进行分类,kNN的方法是首先计算从样本t到所有训练样本的欧几里得距离,然后找到距离它们最短的k个训练样本,并使用出现次数最多的类别. k个训练样本. 样本t的类别.

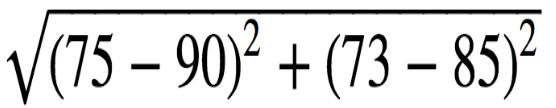

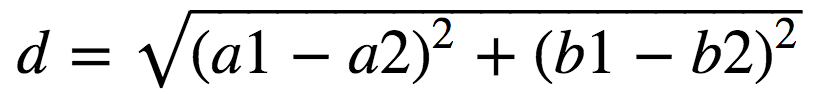

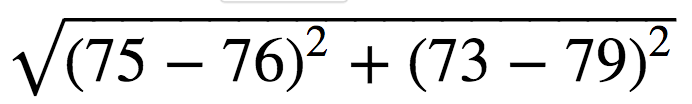

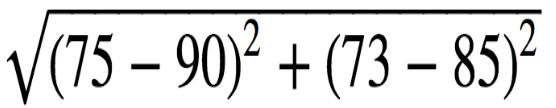

欧氏距离的计算公式:

假设每个样本都有两个特征值,例如A: (a1,b1)B: (a2,b2),则AB的欧几里得距离为

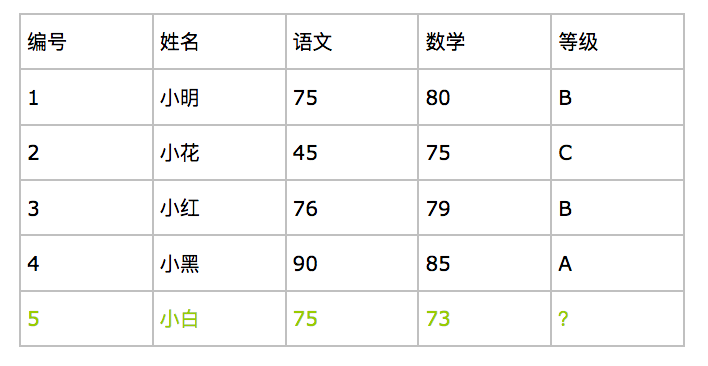

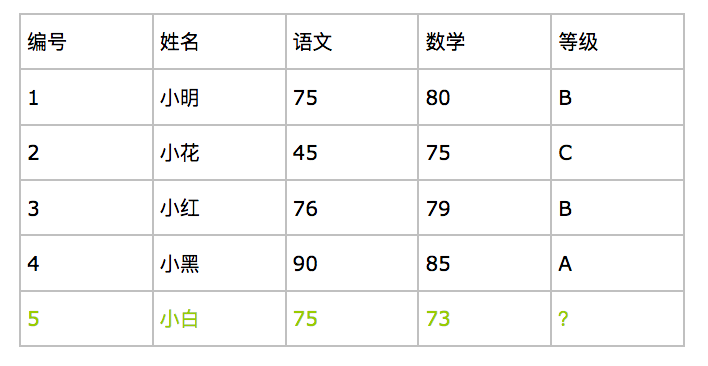

例如: 根据下图中前四名学生的成绩和成绩来预测第五名小白的成绩.

我们可以看到: 汉语和数学成绩是学生的特征,而成绩是学生的类别.

前四个学生是训练样本,第五个学生是测试样本. 现在,我们使用kNN算法来预测第五名学生的成绩,而k为3.

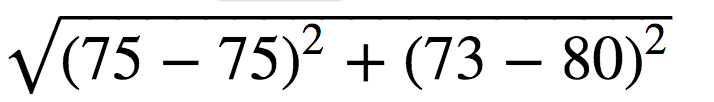

我们可以根据上面的欧几里德距离公式进行计算

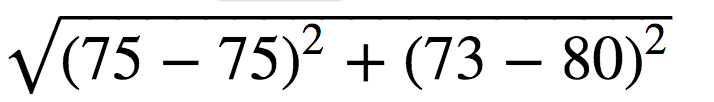

d(5-1)=

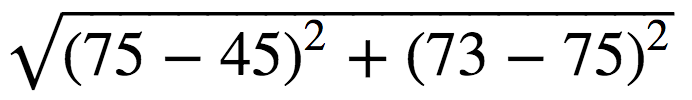

= 7 d(5-2)=

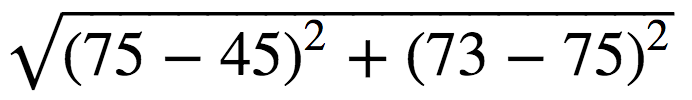

= 30

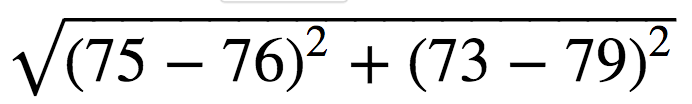

d(5-3)=

= 6 d(5-4)=

= 19.2

由于k为3,我们寻找3个最接近的样本,即编号分别为3、1,和4的学生,其成绩分别为B,B和A. 在这三个样本的分类中,B出现两次,A和B出现次数最多,因此5号学生的等级可能是B

通用Python模块

NumPy: NumPy是Python的开源数值计算扩展. 该工具可用于存储和处理大型矩阵,并且比Python自己的嵌套列表结构更有效.

PIL: Python Imaging Library,是Python平台事实上的图像处理标准库,具有非常强大的功能和易于使用的API. 但是PIL软件包主要用于Python2,并且与Python3不兼容,因此Pillow用于Python3,Daniel根据PIL移植了Pillow. 两者的用法是相同的.

以上两个Python库均可通过pip安装.

pip3 install [name]

Python附带了一个标准库: shutil模块提供了大量的高级文件操作,尤其是用于文件的复制和删除. 主要功能是目录和文件操作以及压缩操作. 操作员模块是Python操作员库,而os模块是Python系统和与操作系统相关的功能库.

第二,对图片进行特征提取

1. 采集手写字母的图片资料

有许多网站提供机器学习数据集. 例如,知乎整理了我采集的手写字母图片资源. 以下链接是: 密码: i725 by_class.zip压缩包是已分类图片的样本,您可以直接下载使用.

2. 提取图片素材的特征

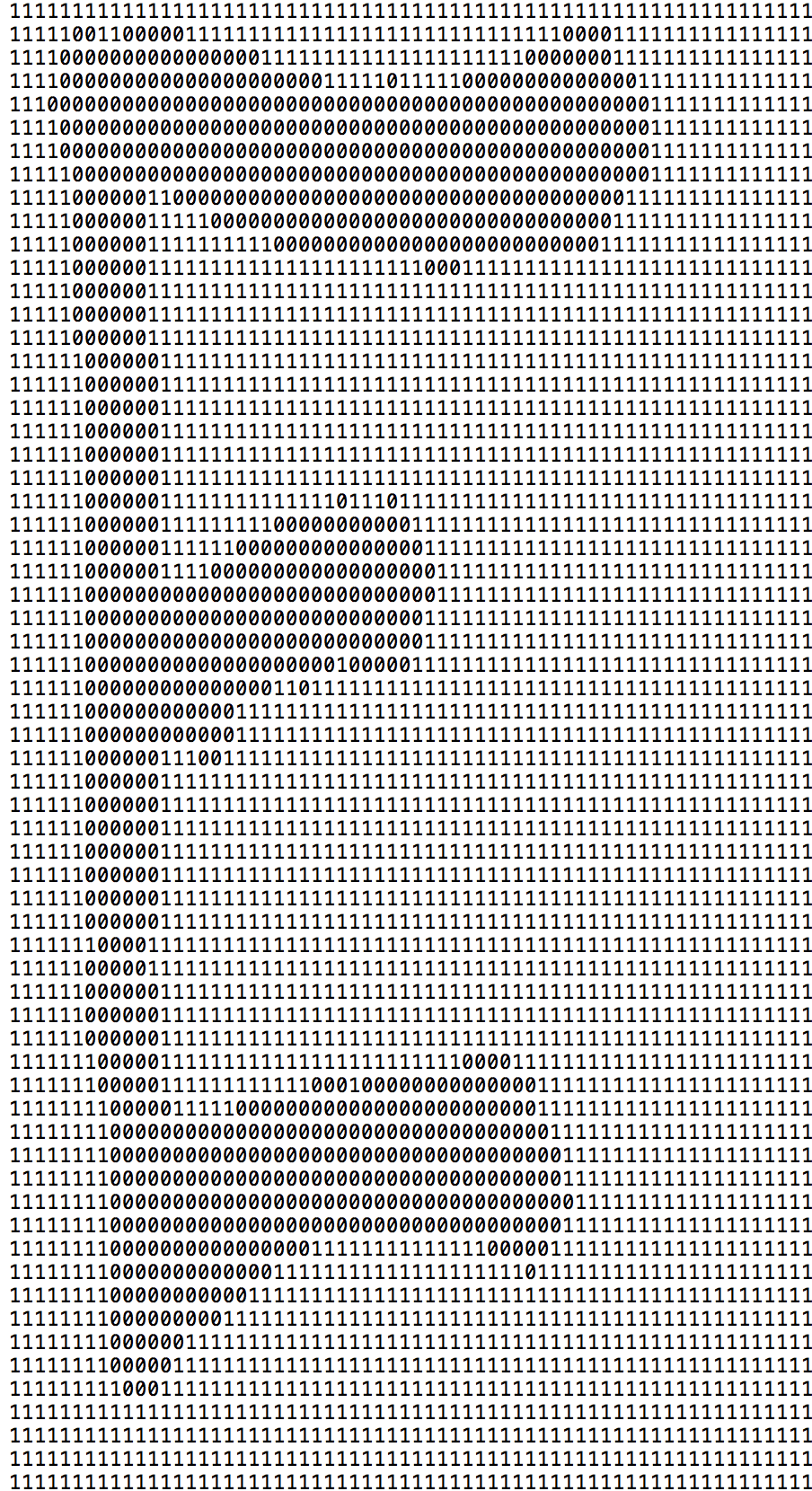

最简单的方法是将图片转换为由0和1组成的txt文件,例如

转换代码如下:

1 import os

2 import shutil

3 from PIL import Image

4

5

6 # image_file_prefix png图片所在的文件夹

7 # file_name png png图片的名字

8 # txt_path_prefix 转换后txt 文件所在的文件夹

9 def generate_txt_image(image_file_prefix, file_name, txt_path_prefix):

10 """将图片处理成只有0 和 1 的txt 文件"""

11 # 将png图片转换成二值图并截取四周多余空白部分

12 image_path = os.path.join(image_file_prefix, file_name)

13 # convert('L') 将图片转为灰度图 convert('1') 将图片转为二值图

14 img = Image.open(image_path, 'r').convert('1').crop((32, 32, 96, 96))

15 # 指定转换后的宽 高

16 width, height = 32, 32

17 img.thumbnail((width, height), Image.ANTIALIAS)

18 # 将二值图片转换为0 1,存储到二位数组arr中

19 arr = []

20 for i in range(width):

21 pixels = []

22 for j in range(height):

23 pixel = int(img.getpixel((j, i)))

24 pixel = 0 if pixel == 0 else 1

25 pixels.append(pixel)

26 arr.append(pixels)

27

28 # 创建txt文件(mac下使用os.mknod()创建文件需要root权限,这里改用复制的方式)

29 text_image_file = os.path.join(txt_path_prefix, file_name.split('.')[0] + '.txt')

30 empty_txt_path = "/Users/beiyan/Downloads/empty.txt"

31 shutil.copyfile(empty_txt_path, text_image_file)

32

33 # 写入文件

34 with open(text_image_file, 'w') as text_file_object:

35 for line in arr:

36 for e in line:

37 text_file_object.write(str(e))

38 text_file_object.write("\n")

将所有材料转换为txt后,它们分为两个部分: 训练样本和测试样本.

三,kNN算法的实现

1. 将txt文件转换为一维数组的方法:

1 def img2vector(filename, width, height):

2 """将txt文件转为一维数组"""

3 return_vector = np.zeros((1, width * height))

4 fr = open(filename)

5 for i in range(height):

6 line = fr.readline()

7 for j in range(width):

8 return_vector[0, height * i + j] = int(line[j])

9 return return_vector

2. 对测试样本执行kNN分类,并返回测试样本的类别:

1 import numpy as np

2 import os

3 import operator

4

5

6 # test_set 单个测试样本

7 # train_set 训练样本二维数组

8 # labels 训练样本对应的分类

9 # k k值

10 def classify(test_set, train_set, labels, k):

11 """对测试样本进行kNN分类,返回测试样本的类别"""

12 # 获取训练样本条数

13 train_size = train_set.shape[0]

14

15 # 计算特征值的差值并求平方

16 # tile(A,(m,n)),功能是将数组A行重复m次 列重复n次

17 diff_mat = np.tile(test_set, (train_size, 1)) - train_set

18 sq_diff_mat = diff_mat ** 2

19

20 # 计算欧式距离 存储到数组 distances

21 sq_distances = sq_diff_mat.sum(axis=1)

22 distances = sq_distances ** 0.5

23

24 # 按距离由小到大排序对索引进行排序

25 sorted_index = distances.argsort()

26

27 # 求距离最短k个样本中 出现最多的分类

28 class_count = {}

29 for i in range(k):

30 near_label = labels[sorted_index[i]]

31 class_count[near_label] = class_count.get(near_label, 0) + 1

32 sorted_class_count = sorted(class_count.items(), key=operator.itemgetter(1), reverse=True)

33 return sorted_class_count[0][0]

3. 统计分类错误率

1 # train_data_path 训练样本文件夹

2 # test_data_path 测试样本文件夹

3 # k k个最近邻居

4 def get_error_rate(train_data_path, test_data_path, k):

5 """统计识别错误率"""

6 width, height = 32, 32

7 train_labels = []

8

9 training_file_list = os.listdir(train_data_path)

10 train_size = len(training_file_list)

11

12 # 生成全为0的训练集数组

13 train_set = np.zeros((train_size, width * height))

14

15 # 读取训练样本

16 for i in range(train_size):

17 file = training_file_list[i]

18 file_name = file.split('.')[0]

19 label = str(file_name.split('_')[0])

20 train_labels.append(label)

21 train_set[i, :] = img2vector(os.path.join(train_data_path, training_file_list[i]), width, height)

22

23 test_file_list = os.listdir(test_data_path)

24 # 识别错误的个数

25 error_count = 0.0

26 # 测试样本的个数

27 test_count = len(test_file_list)

28

29 # 统计识别错误的个数

30 for i in range(test_count):

31 file = test_file_list[i]

32 true_label = file.split('.')[0].split('_')[0]

33

34 test_set = img2vector(os.path.join(test_data_path, test_file_list[i]), width, height)

35 test_label = classify(test_set, train_set, train_labels, k)

36 print(true_label, test_label)

37 if test_label != true_label:

38 error_count += 1.0

39 percent = error_count / float(test_count)

40 print("识别错误率是:{}".format(str(percent)))

以上完整的代码地址:

4. 测试结果

训练样本: 0-9,a-z,A-Z,共有62个字符,每个字符选择120个训练样本,总共7440个训练样本. 每个角色选择20个测试样本,总共1200个测试样本.

尝试更改条件,测得的识别率如下:

四个kNN算法分析

从以上部分的结果可以看出,knn算法对手写字母的识别率并不理想.

原因可能如下:

1. 图像特征提取太简单,图像的边缘更加空白,图像中字母的中心位置可能并非全部对应

2. 由于某些英文字母的大小写相似,因此很容易识别错误.

3. 样本量很小,每个角色最多只有300个训练样本. 真正的训练需要海量数据

在随后的文章中,尝试使用其他学习算法来提高分类识别率. 欢迎同道人有更好的意见! 查看全部

本文主要使用kNN算法对字母图片进行特征提取和分类. 内容如下:

kNN算法和相关的Python模块介绍,字母图像特征提取,kNN算法和kNN算法分析

I. kNN算法简介

K最近邻(kNN,k-NearestNeighbor)分类算法是机器学习算法中最简单的方法之一. 所谓的K个最近邻居是指k个最近邻居,这意味着每个样本都可以由其最近的k个邻居表示. 我们将样本分为训练样本和测试样本. 为了对测试样本t进行分类,kNN的方法是首先计算从样本t到所有训练样本的欧几里得距离,然后找到距离它们最短的k个训练样本,并使用出现次数最多的类别. k个训练样本. 样本t的类别.

欧氏距离的计算公式:

假设每个样本都有两个特征值,例如A: (a1,b1)B: (a2,b2),则AB的欧几里得距离为

例如: 根据下图中前四名学生的成绩和成绩来预测第五名小白的成绩.

我们可以看到: 汉语和数学成绩是学生的特征,而成绩是学生的类别.

前四个学生是训练样本,第五个学生是测试样本. 现在,我们使用kNN算法来预测第五名学生的成绩,而k为3.

我们可以根据上面的欧几里德距离公式进行计算

d(5-1)=

= 7 d(5-2)=

= 30

d(5-3)=

= 6 d(5-4)=

= 19.2

由于k为3,我们寻找3个最接近的样本,即编号分别为3、1,和4的学生,其成绩分别为B,B和A. 在这三个样本的分类中,B出现两次,A和B出现次数最多,因此5号学生的等级可能是B

通用Python模块

NumPy: NumPy是Python的开源数值计算扩展. 该工具可用于存储和处理大型矩阵,并且比Python自己的嵌套列表结构更有效.

PIL: Python Imaging Library,是Python平台事实上的图像处理标准库,具有非常强大的功能和易于使用的API. 但是PIL软件包主要用于Python2,并且与Python3不兼容,因此Pillow用于Python3,Daniel根据PIL移植了Pillow. 两者的用法是相同的.

以上两个Python库均可通过pip安装.

pip3 install [name]

Python附带了一个标准库: shutil模块提供了大量的高级文件操作,尤其是用于文件的复制和删除. 主要功能是目录和文件操作以及压缩操作. 操作员模块是Python操作员库,而os模块是Python系统和与操作系统相关的功能库.

第二,对图片进行特征提取

1. 采集手写字母的图片资料

有许多网站提供机器学习数据集. 例如,知乎整理了我采集的手写字母图片资源. 以下链接是: 密码: i725 by_class.zip压缩包是已分类图片的样本,您可以直接下载使用.

2. 提取图片素材的特征

最简单的方法是将图片转换为由0和1组成的txt文件,例如

转换代码如下:

1 import os

2 import shutil

3 from PIL import Image

4

5

6 # image_file_prefix png图片所在的文件夹

7 # file_name png png图片的名字

8 # txt_path_prefix 转换后txt 文件所在的文件夹

9 def generate_txt_image(image_file_prefix, file_name, txt_path_prefix):

10 """将图片处理成只有0 和 1 的txt 文件"""

11 # 将png图片转换成二值图并截取四周多余空白部分

12 image_path = os.path.join(image_file_prefix, file_name)

13 # convert('L') 将图片转为灰度图 convert('1') 将图片转为二值图

14 img = Image.open(image_path, 'r').convert('1').crop((32, 32, 96, 96))

15 # 指定转换后的宽 高

16 width, height = 32, 32

17 img.thumbnail((width, height), Image.ANTIALIAS)

18 # 将二值图片转换为0 1,存储到二位数组arr中

19 arr = []

20 for i in range(width):

21 pixels = []

22 for j in range(height):

23 pixel = int(img.getpixel((j, i)))

24 pixel = 0 if pixel == 0 else 1

25 pixels.append(pixel)

26 arr.append(pixels)

27

28 # 创建txt文件(mac下使用os.mknod()创建文件需要root权限,这里改用复制的方式)

29 text_image_file = os.path.join(txt_path_prefix, file_name.split('.')[0] + '.txt')

30 empty_txt_path = "/Users/beiyan/Downloads/empty.txt"

31 shutil.copyfile(empty_txt_path, text_image_file)

32

33 # 写入文件

34 with open(text_image_file, 'w') as text_file_object:

35 for line in arr:

36 for e in line:

37 text_file_object.write(str(e))

38 text_file_object.write("\n")

将所有材料转换为txt后,它们分为两个部分: 训练样本和测试样本.

三,kNN算法的实现

1. 将txt文件转换为一维数组的方法:

1 def img2vector(filename, width, height):

2 """将txt文件转为一维数组"""

3 return_vector = np.zeros((1, width * height))

4 fr = open(filename)

5 for i in range(height):

6 line = fr.readline()

7 for j in range(width):

8 return_vector[0, height * i + j] = int(line[j])

9 return return_vector

2. 对测试样本执行kNN分类,并返回测试样本的类别:

1 import numpy as np

2 import os

3 import operator

4

5

6 # test_set 单个测试样本

7 # train_set 训练样本二维数组

8 # labels 训练样本对应的分类

9 # k k值

10 def classify(test_set, train_set, labels, k):

11 """对测试样本进行kNN分类,返回测试样本的类别"""

12 # 获取训练样本条数

13 train_size = train_set.shape[0]

14

15 # 计算特征值的差值并求平方

16 # tile(A,(m,n)),功能是将数组A行重复m次 列重复n次

17 diff_mat = np.tile(test_set, (train_size, 1)) - train_set

18 sq_diff_mat = diff_mat ** 2

19

20 # 计算欧式距离 存储到数组 distances

21 sq_distances = sq_diff_mat.sum(axis=1)

22 distances = sq_distances ** 0.5

23

24 # 按距离由小到大排序对索引进行排序

25 sorted_index = distances.argsort()

26

27 # 求距离最短k个样本中 出现最多的分类

28 class_count = {}

29 for i in range(k):

30 near_label = labels[sorted_index[i]]

31 class_count[near_label] = class_count.get(near_label, 0) + 1

32 sorted_class_count = sorted(class_count.items(), key=operator.itemgetter(1), reverse=True)

33 return sorted_class_count[0][0]

3. 统计分类错误率

1 # train_data_path 训练样本文件夹

2 # test_data_path 测试样本文件夹

3 # k k个最近邻居

4 def get_error_rate(train_data_path, test_data_path, k):

5 """统计识别错误率"""

6 width, height = 32, 32

7 train_labels = []

8

9 training_file_list = os.listdir(train_data_path)

10 train_size = len(training_file_list)

11

12 # 生成全为0的训练集数组

13 train_set = np.zeros((train_size, width * height))

14

15 # 读取训练样本

16 for i in range(train_size):

17 file = training_file_list[i]

18 file_name = file.split('.')[0]

19 label = str(file_name.split('_')[0])

20 train_labels.append(label)

21 train_set[i, :] = img2vector(os.path.join(train_data_path, training_file_list[i]), width, height)

22

23 test_file_list = os.listdir(test_data_path)

24 # 识别错误的个数

25 error_count = 0.0

26 # 测试样本的个数

27 test_count = len(test_file_list)

28

29 # 统计识别错误的个数

30 for i in range(test_count):

31 file = test_file_list[i]

32 true_label = file.split('.')[0].split('_')[0]

33

34 test_set = img2vector(os.path.join(test_data_path, test_file_list[i]), width, height)

35 test_label = classify(test_set, train_set, train_labels, k)

36 print(true_label, test_label)

37 if test_label != true_label:

38 error_count += 1.0

39 percent = error_count / float(test_count)

40 print("识别错误率是:{}".format(str(percent)))

以上完整的代码地址:

4. 测试结果

训练样本: 0-9,a-z,A-Z,共有62个字符,每个字符选择120个训练样本,总共7440个训练样本. 每个角色选择20个测试样本,总共1200个测试样本.

尝试更改条件,测得的识别率如下:

四个kNN算法分析

从以上部分的结果可以看出,knn算法对手写字母的识别率并不理想.

原因可能如下:

1. 图像特征提取太简单,图像的边缘更加空白,图像中字母的中心位置可能并非全部对应

2. 由于某些英文字母的大小写相似,因此很容易识别错误.

3. 样本量很小,每个角色最多只有300个训练样本. 真正的训练需要海量数据

在随后的文章中,尝试使用其他学习算法来提高分类识别率. 欢迎同道人有更好的意见!

[百度算法]飓风算法3.0在线打击跨域集合和站点组网站吗?

采集交流 • 优采云 发表了文章 • 0 个评论 • 172 次浏览 • 2020-08-08 18:13

飓风算法是百度搜索公司推出的一种搜索引擎算法,用于抑制网站的不良采集行为,为高质量的原创内容提供更多的展示机会,并促进搜索生态的健康发展.

飓风算法3.0: 2019年8月8日,百度搜索将飓风算法升级为飓风算法3.0,主要针对跨域采集和百度搜索下PC站点,H5站点以及智能小程序中站点组的批处理构建. 获取搜索流量的行为. Hurricane Algorithm 3.0旨在维护健康的移动生态,确保用户体验,并确保高质量的站点/智能小程序能够获得合理的流量分配.

飓风算法2.0: 2018年9月13日,百度升级了飓风算法并发布了飓风算法2.0,主要针对五种类型的采集行为,包括明显的采集痕迹,内容拼接,网站上的大量内容采集以及跨域集合. Hurricane Algorithm 2.0旨在确保搜索用户的浏览体验并保护搜索生态的健康发展. 对于违反规定的网站,百度搜索将根据问题的严重程度限制对搜索显示的处理. 对于首次违反规定的网站,纠正后取消显示限制的期限为1个月;对于第二次违反规定的网站,百度搜索不会将其发布.

Hurricane Algorithm 1.0: 2017年7月4日,百度的搜索资源平台宣布推出Hurricane Algorithm,该计划旨在严厉打击以不良采集为主要内容来源的网站. 同时,百度搜索将从索引库中彻底删除不良采集. 链接为高质量的原创内容提供更多的展示机会,并促进搜索生态的健康发展. 飓风算法会定期生成惩罚数据,并同时根据情况随时调整迭代次数,这反映了百度搜索对不良收款的零容忍度. 对于高质量的原创网站,如果您发现该网站的索引已大大减少并且访问量已大幅下降,则可以在百度搜索资源平台的反馈中心提供反馈 查看全部

为了创建良好的搜索内容生态并保护搜索用户的浏览体验,百度发布了飓风算法,该算法旨在严厉打击严酷的采集行为和网站组问题,并将覆盖PC网站,H5网站和百度搜索下的智能小网站. 程序和其他内容. 对于算法所涵盖的站点/智能小应用程序,将根据违规的严重性来限制搜索结果的显示. 对于首次违反规定的网站,修改后的曝光期为一个月;对于第二次违反的网站,百度将不会予以释放.

飓风算法是百度搜索公司推出的一种搜索引擎算法,用于抑制网站的不良采集行为,为高质量的原创内容提供更多的展示机会,并促进搜索生态的健康发展.

飓风算法3.0: 2019年8月8日,百度搜索将飓风算法升级为飓风算法3.0,主要针对跨域采集和百度搜索下PC站点,H5站点以及智能小程序中站点组的批处理构建. 获取搜索流量的行为. Hurricane Algorithm 3.0旨在维护健康的移动生态,确保用户体验,并确保高质量的站点/智能小程序能够获得合理的流量分配.

飓风算法2.0: 2018年9月13日,百度升级了飓风算法并发布了飓风算法2.0,主要针对五种类型的采集行为,包括明显的采集痕迹,内容拼接,网站上的大量内容采集以及跨域集合. Hurricane Algorithm 2.0旨在确保搜索用户的浏览体验并保护搜索生态的健康发展. 对于违反规定的网站,百度搜索将根据问题的严重程度限制对搜索显示的处理. 对于首次违反规定的网站,纠正后取消显示限制的期限为1个月;对于第二次违反规定的网站,百度搜索不会将其发布.

Hurricane Algorithm 1.0: 2017年7月4日,百度的搜索资源平台宣布推出Hurricane Algorithm,该计划旨在严厉打击以不良采集为主要内容来源的网站. 同时,百度搜索将从索引库中彻底删除不良采集. 链接为高质量的原创内容提供更多的展示机会,并促进搜索生态的健康发展. 飓风算法会定期生成惩罚数据,并同时根据情况随时调整迭代次数,这反映了百度搜索对不良收款的零容忍度. 对于高质量的原创网站,如果您发现该网站的索引已大大减少并且访问量已大幅下降,则可以在百度搜索资源平台的反馈中心提供反馈

优采云采集器是一款非常实用的网站信息采集工具,它具有零门槛、多

采集交流 • 优采云 发表了文章 • 0 个评论 • 378 次浏览 • 2020-08-08 09:14

软件简介优采云采集器是一个很好的Web信息采集工具,是新一代可视智能采集器的代表作. 视觉采集器,采集就像构建基块,功能模块的自由组合,视觉提取或Web元素的操作,自动登录,自动发布以及自动识别验证码一样. 这是一个通用的浏览器. 您可以快速创建自动化脚本,甚至可以生成独立的应用程序来销售和赚钱!

软件功能的零阈值

如果您不了解网络爬虫技术,可以上网,那么您将采集网站数据

多个引擎,高速且稳定

内置高速浏览器引擎,还可以切换到HTTP引擎模式运行,数据采集更加高效. 它还具有内置的JSON引擎,无需分析JSON数据结构,直观地选择JSON内容.

适用于各种网站

可以采集99%的Internet站点,包括单页应用程序Ajax加载和其他动态类型的站点.

软件功能1.该软件易于操作,单击鼠标即可轻松选择要捕获的内容;

2. 支持三种高速引擎: 浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器以及原创内存优化,因此浏览器集合也可以高速运行,甚至可以快速转换为HTTP方式运行,享受更高的采集速度!捕获JSON数据时,还可以使用浏览器可视化方法来选择需要用鼠标捕获的内容. 无需分析JSON数据结构,因此非网页专业设计人员可以轻松获取所需数据;

3. 无需分析网页请求和源代码,但它支持更多网页采集;先进的智能算法可以一键生成目标元素XPATH,自动识别网页列表,自动识别分页中的下一页按钮.

4. 支持丰富的数据导出方法,可以通过以下方式将其导出到txt文件,html文件,csv文件,excel文件或现有数据库(如sqlite数据库,access数据库,sqlserver数据库,mysql数据库)中. 可以轻松导出到目标网站数据库.

产品优势可视化指南

所有采集元素,自动生成采集数据

计划任务

灵活定义运行时间,全自动运行

多引擎支持

支持多个采集引擎,内置的高速浏览器内核,HTTP引擎和JSON引擎

智能识别

自动识别网页列表,采集字段和分页等.

拦截请求

自定义阻止域名,以方便过滤异地广告并提高采集速度

多个数据导出

可以导出到Txt,Excel,MySQL,SQLServer,SQlite,Access,网站等.

安装说明进入软件下载页面,单击立即下载按钮以下载软件

下载并解压缩后,双击setup1.0.exe以启动安装程序(版本为1.0后,后续的新版本将有所不同)

按照安装向导的说明进行操作,然后一直单击“下一步”按钮以完成安装.

常见问题解答如何在采集数据时避免重复数据?

运行采集任务时,如果该任务之前已采集过数据,如果采集前未清除原创数据,则新采集的数据将以附加的形式添加到本地采集库中,这样就可以重复采集一些已经采集的数据,然后再次放入数据库中. 此外,如果目标网页本身具有重复数据,则也可能导致数据重复. 如何避免重复采集数据?

该方法非常简单,我们希望不允许重复该字段的内容,只需单击该字段标题上的三角形符号,然后选中“过滤重复项”复选框,然后单击“确定”.

如何手动生成字段?

点击“添加字段”按钮

在列表的任何行中单击要提取的元素,例如,要提取标题和链接地址,请用鼠标左键单击标题.

当您单击Web链接时,系统会提示您是否使用链接地址

如果要同时提取链接标题和链接地址,请单击“是”,如果只需要提取标题文本,请单击“否”,这里我们单击“是”

系统将自动生成标题和链接地址字段,并在字段列表中显示提取的字段内容. 当您点击表格底部的字段标题时,匹配的内容将在网页上以黄色背景突出显示.

如何在列表中标记其他字段?单击添加字段,然后重复上述操作. 查看全部

优采云采集器是一个非常实用的网站信息采集工具. 它具有零阈值,多个引擎和多种功能的特性. 该软件使不了解Web爬网技术的人员可以轻松地采集网络信息,适用于99%的网站,并且还可以智能地避免获取重复数据.

软件简介优采云采集器是一个很好的Web信息采集工具,是新一代可视智能采集器的代表作. 视觉采集器,采集就像构建基块,功能模块的自由组合,视觉提取或Web元素的操作,自动登录,自动发布以及自动识别验证码一样. 这是一个通用的浏览器. 您可以快速创建自动化脚本,甚至可以生成独立的应用程序来销售和赚钱!

软件功能的零阈值

如果您不了解网络爬虫技术,可以上网,那么您将采集网站数据

多个引擎,高速且稳定

内置高速浏览器引擎,还可以切换到HTTP引擎模式运行,数据采集更加高效. 它还具有内置的JSON引擎,无需分析JSON数据结构,直观地选择JSON内容.

适用于各种网站

可以采集99%的Internet站点,包括单页应用程序Ajax加载和其他动态类型的站点.

软件功能1.该软件易于操作,单击鼠标即可轻松选择要捕获的内容;

2. 支持三种高速引擎: 浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器以及原创内存优化,因此浏览器集合也可以高速运行,甚至可以快速转换为HTTP方式运行,享受更高的采集速度!捕获JSON数据时,还可以使用浏览器可视化方法来选择需要用鼠标捕获的内容. 无需分析JSON数据结构,因此非网页专业设计人员可以轻松获取所需数据;

3. 无需分析网页请求和源代码,但它支持更多网页采集;先进的智能算法可以一键生成目标元素XPATH,自动识别网页列表,自动识别分页中的下一页按钮.

4. 支持丰富的数据导出方法,可以通过以下方式将其导出到txt文件,html文件,csv文件,excel文件或现有数据库(如sqlite数据库,access数据库,sqlserver数据库,mysql数据库)中. 可以轻松导出到目标网站数据库.

产品优势可视化指南

所有采集元素,自动生成采集数据

计划任务

灵活定义运行时间,全自动运行

多引擎支持

支持多个采集引擎,内置的高速浏览器内核,HTTP引擎和JSON引擎

智能识别

自动识别网页列表,采集字段和分页等.

拦截请求

自定义阻止域名,以方便过滤异地广告并提高采集速度

多个数据导出

可以导出到Txt,Excel,MySQL,SQLServer,SQlite,Access,网站等.

安装说明进入软件下载页面,单击立即下载按钮以下载软件

下载并解压缩后,双击setup1.0.exe以启动安装程序(版本为1.0后,后续的新版本将有所不同)

按照安装向导的说明进行操作,然后一直单击“下一步”按钮以完成安装.

常见问题解答如何在采集数据时避免重复数据?

运行采集任务时,如果该任务之前已采集过数据,如果采集前未清除原创数据,则新采集的数据将以附加的形式添加到本地采集库中,这样就可以重复采集一些已经采集的数据,然后再次放入数据库中. 此外,如果目标网页本身具有重复数据,则也可能导致数据重复. 如何避免重复采集数据?

该方法非常简单,我们希望不允许重复该字段的内容,只需单击该字段标题上的三角形符号,然后选中“过滤重复项”复选框,然后单击“确定”.

如何手动生成字段?

点击“添加字段”按钮

在列表的任何行中单击要提取的元素,例如,要提取标题和链接地址,请用鼠标左键单击标题.

当您单击Web链接时,系统会提示您是否使用链接地址

如果要同时提取链接标题和链接地址,请单击“是”,如果只需要提取标题文本,请单击“否”,这里我们单击“是”

系统将自动生成标题和链接地址字段,并在字段列表中显示提取的字段内容. 当您点击表格底部的字段标题时,匹配的内容将在网页上以黄色背景突出显示.

如何在列表中标记其他字段?单击添加字段,然后重复上述操作.

学习了解大数据数据采集工具的使用

采集交流 • 优采云 发表了文章 • 0 个评论 • 288 次浏览 • 2020-08-07 23:30

官方网站:

简介: 优采云采集器是具有内置采集模板的可视采集器,并支持各种Web数据采集.

优点:

1. 支持自定义模式,可视化采集操作,易于使用;

2. 支持简单采集模式,提供官方采集模板,支持云采集操作;

3. 支持防阻塞措施,例如代理IP交换和验证码服务;

4. 支持多种数据格式导出.

缺点:

1. 功能使用的门槛很高,本地采集期间许多功能受到限制,而云采集费用较高;

2. 采集速度很慢,许多操作必须停滞. 云采集说它快10倍,但并不明显;

3. 仅支持Windows版本,不支持其他操作系统.

2. 优采云采集器:

官方网站:

简介: 优采云采集器是一个Web数据捕获,处理,分析和挖掘软件. 它可以快速,灵活地获取分散在网页上的信息,并通过强大的处理功能准确地挖掘所需的数据.

优点:

1. 国内老藏家,经过多年的积累,具有丰富的采集功能;

2. 采集速度比较快,界面比较完整,并且支持PHP和C#插件扩展;

3. 支持多种数据格式导出,可以执行数据替换等处理.

缺点:

1. 该产品越旧,就越容易陷入其固有的体验中,而油彩云很难摆脱这个问题.

2. 虽然功能丰富,但功能堆积在那里,用户体验不好,人们也不知道从哪里开始;

3. 学习过它的人会觉得自己很强大,但是对于新手来说有一定的门槛. 没有一段时间的学习就很难学习,而从零开始的学习基本上是不可能的.

4. 仅支持Windows版本,不支持其他操作系统.

3. 优采云采集器:

官方网站:

简介: 优采云采集器是由前Google搜索技术团队基于人工智能技术开发的新一代网页采集软件. 该软件功能强大且非常易于操作.

优点:

1. 支持智能采集模式,输入URL即可智能识别采集对象,无需配置采集规则,操作非常简单;

2. 支持流程图模式,可视化的操作流程,可通过简单的操作生成各种复杂的采集规则;

3. 支持防阻塞措施,例如代理IP交换等;

4. 支持多种数据格式导出;

5. 支持定时采集和自动发布,具有丰富的发布界面;

6. 支持Windows,Mac和Linux版本.

缺点: 该软件已经很长时间没有启动,并且某些功能仍在改进中. 暂时不支持云采集.

4. 优采云运爬行动物

官方网站:

简介: 优采云运是一个大数据应用开发平台,为开发人员提供了一套完整的数据采集,数据分析和机器学习开发工具,并为企业提供专业的数据捕获,实时数据监控和数据分析服务.

优点:

1. 强大的功能,包括云采集器,API,机器学习,数据清理,数据销售,数据定制和私有化部署等;

2. 可以隐藏纯云操作,没有压力的跨系统操作,隐私保护和用户IP.

3. 在云爬虫市场中,从零开始的用户可以直接调用开发的爬虫,开发人员可以根据官方的云开发环境开发并上传自己的爬虫程序;

4. 领先的防爬技术,例如直接访问代理IP和自动登录验证码识别等,整个过程是自动化的,无需人工参与;

5. 丰富的发布界面,采集结果以丰富的表格形式显示;

缺点: 它的优点在一定程度上也成为缺点,因为它是面向开发人员的爬虫开发系统,并提供丰富的开发功能. 该网站看起来非常技术和非常专业,尽管官方也提供了现成的爬虫产品,例如云爬虫市场,并向爬虫开发者开放以丰富爬虫市场的内容,但是对于它来说,理解起来并不容易. 技术基础为零的用户,因此有一定的使用门槛. 查看全部

1. 优采云采集器:

官方网站:

简介: 优采云采集器是具有内置采集模板的可视采集器,并支持各种Web数据采集.

优点:

1. 支持自定义模式,可视化采集操作,易于使用;

2. 支持简单采集模式,提供官方采集模板,支持云采集操作;

3. 支持防阻塞措施,例如代理IP交换和验证码服务;

4. 支持多种数据格式导出.

缺点:

1. 功能使用的门槛很高,本地采集期间许多功能受到限制,而云采集费用较高;

2. 采集速度很慢,许多操作必须停滞. 云采集说它快10倍,但并不明显;

3. 仅支持Windows版本,不支持其他操作系统.

2. 优采云采集器:

官方网站:

简介: 优采云采集器是一个Web数据捕获,处理,分析和挖掘软件. 它可以快速,灵活地获取分散在网页上的信息,并通过强大的处理功能准确地挖掘所需的数据.

优点:

1. 国内老藏家,经过多年的积累,具有丰富的采集功能;

2. 采集速度比较快,界面比较完整,并且支持PHP和C#插件扩展;

3. 支持多种数据格式导出,可以执行数据替换等处理.

缺点:

1. 该产品越旧,就越容易陷入其固有的体验中,而油彩云很难摆脱这个问题.

2. 虽然功能丰富,但功能堆积在那里,用户体验不好,人们也不知道从哪里开始;

3. 学习过它的人会觉得自己很强大,但是对于新手来说有一定的门槛. 没有一段时间的学习就很难学习,而从零开始的学习基本上是不可能的.

4. 仅支持Windows版本,不支持其他操作系统.

3. 优采云采集器:

官方网站:

简介: 优采云采集器是由前Google搜索技术团队基于人工智能技术开发的新一代网页采集软件. 该软件功能强大且非常易于操作.

优点:

1. 支持智能采集模式,输入URL即可智能识别采集对象,无需配置采集规则,操作非常简单;

2. 支持流程图模式,可视化的操作流程,可通过简单的操作生成各种复杂的采集规则;

3. 支持防阻塞措施,例如代理IP交换等;

4. 支持多种数据格式导出;

5. 支持定时采集和自动发布,具有丰富的发布界面;

6. 支持Windows,Mac和Linux版本.

缺点: 该软件已经很长时间没有启动,并且某些功能仍在改进中. 暂时不支持云采集.

4. 优采云运爬行动物

官方网站:

简介: 优采云运是一个大数据应用开发平台,为开发人员提供了一套完整的数据采集,数据分析和机器学习开发工具,并为企业提供专业的数据捕获,实时数据监控和数据分析服务.

优点:

1. 强大的功能,包括云采集器,API,机器学习,数据清理,数据销售,数据定制和私有化部署等;

2. 可以隐藏纯云操作,没有压力的跨系统操作,隐私保护和用户IP.

3. 在云爬虫市场中,从零开始的用户可以直接调用开发的爬虫,开发人员可以根据官方的云开发环境开发并上传自己的爬虫程序;

4. 领先的防爬技术,例如直接访问代理IP和自动登录验证码识别等,整个过程是自动化的,无需人工参与;

5. 丰富的发布界面,采集结果以丰富的表格形式显示;

缺点: 它的优点在一定程度上也成为缺点,因为它是面向开发人员的爬虫开发系统,并提供丰富的开发功能. 该网站看起来非常技术和非常专业,尽管官方也提供了现成的爬虫产品,例如云爬虫市场,并向爬虫开发者开放以丰富爬虫市场的内容,但是对于它来说,理解起来并不容易. 技术基础为零的用户,因此有一定的使用门槛.

基于HITS算法的微博采集系统的设计与实现

采集交流 • 优采云 发表了文章 • 0 个评论 • 385 次浏览 • 2020-08-07 10:20

(2)本文将Web链接分析算法Hits算法应用于微博用户影响力的计算,并将微博用户的注意力与被关注者之间的关系视为网页之间的连接关系,并结合了针对微博用户的特征进行改进,提出基于Hits算法的微博用户影响力评价算法. 改进的算法可以更好地提高排序结果的准确性. (3)在分析系统需求的基础上,设计了基于Hits算法的微博信息采集系统的各个功能模块,主要包括微博内容采集模块,用户信息采集模块,用户关系采集模块以及使用方法. 改进了命中算法采集结果排序模块. 具体地,微博内容采集模块主要实现基于关键词的微博内容采集功能;用户信息采集模块主要根据上一步的用户名采集每个用户的信息,包括用户的好友数. ,粉丝数量,微博数量等;用户关系模块主要用于采集用户之间的粉丝对应关系;采集结果排序模块主要是对采集的结果进行分析,计算用户的影响力,并计算用户的影响力. 大小对采集的结果进行排序,最后将其显示在系统界面上. 最后,数据库表旨在确保所存储数据的完整性和准确性. (4)在系统级设计部分,根据提高内聚力,减少耦合的思想,将系统应用架构分为三层: 数据访问层,域层和表示层;此外,该系统使用的数据库版本是Microsoft SQL Server 2008,开发环境是Visual Studio2010. 最后,通过测试,发现本文设计的系统可以更好地完成数据采集功能并提供排序结果更准确. 查看全部

[摘要]: 微博是微博客的缩写,是博客的一种形式. 这是一种广播式社交网络方法,用于通过用户之间的以下关系共享简短的即时信息. 微博近年来迎来了爆炸性的发展,并逐渐成为互联网上最受欢迎的社交场所之一. 截至2017年9月,新浪微博每月活跃用户达到3.76亿,每日活跃用户达到1.65亿. 微博活跃用户持续稳定增长. 目前,微博网络的影响力越来越大. 政府,企业,学校,名人,甚至主要新闻媒体网站都开放了微博. 越来越多的人参与其中,因此每天在微博上都会产生大量新信息. 为了充分利用海量微博信息,挖掘微博的潜在价值,采集微博关键信息,尤其是粉丝众多,影响力大的用户发布的微博信息,在互联网上. 在分析民意时很有必要. 因此,本文致力于研究微博信息的采集和分析微博用户的影响,并设计和实现基于Hits算法的微博采集系统. 该系统的主要功能是根据关键词采集微博的内容,并根据微博用户的影响对采集的结果进行排序,然后将其呈现给用户. 本文的主要工作包括以下几个方面: (1)阅读了大量文献和相关资料,并对微博,微博信息采集和结果排序算法的研究现状有了初步的了解. 根据系统的研究背景和意义,确定系统的需求分析,确定系统需要实现的两个功能: 信息采集和采集结果分类,并在此基础上学习相关技术,包括网络信息采集技术,API接口调用技术,网页排序算法等.

(2)本文将Web链接分析算法Hits算法应用于微博用户影响力的计算,并将微博用户的注意力与被关注者之间的关系视为网页之间的连接关系,并结合了针对微博用户的特征进行改进,提出基于Hits算法的微博用户影响力评价算法. 改进的算法可以更好地提高排序结果的准确性. (3)在分析系统需求的基础上,设计了基于Hits算法的微博信息采集系统的各个功能模块,主要包括微博内容采集模块,用户信息采集模块,用户关系采集模块以及使用方法. 改进了命中算法采集结果排序模块. 具体地,微博内容采集模块主要实现基于关键词的微博内容采集功能;用户信息采集模块主要根据上一步的用户名采集每个用户的信息,包括用户的好友数. ,粉丝数量,微博数量等;用户关系模块主要用于采集用户之间的粉丝对应关系;采集结果排序模块主要是对采集的结果进行分析,计算用户的影响力,并计算用户的影响力. 大小对采集的结果进行排序,最后将其显示在系统界面上. 最后,数据库表旨在确保所存储数据的完整性和准确性. (4)在系统级设计部分,根据提高内聚力,减少耦合的思想,将系统应用架构分为三层: 数据访问层,域层和表示层;此外,该系统使用的数据库版本是Microsoft SQL Server 2008,开发环境是Visual Studio2010. 最后,通过测试,发现本文设计的系统可以更好地完成数据采集功能并提供排序结果更准确.

AjaxAI v2.0.0.0免费版本

采集交流 • 优采云 发表了文章 • 0 个评论 • 191 次浏览 • 2020-08-07 08:16

概述

AjaxAI是免费的Web数据采集软件,可视化的定制服务,丰富的界面和扩展,防屏蔽BT分发操作,丰富的界面和扩展,包括主流网站采集APP!

功能说明

获取数据

可以捕获任何网页数据,并且只需单击鼠标即可轻松获得所见即所得的操作模式.

自动运行

每天都很忙,频繁且单调地处理相同的网页操作. 开发一个Web应用程序,让它为您执行.

定时执行

您需要定期打开网站以查看和复制更改的数据. 您只需为这些事情制定计划任务计划.

云采集

计算机的采集效果很差. 它通常禁止用户阻止IP,并且代理IP速度很慢. 然后尝试采集云. 成千上万的异步用户和云服务可以同时满足您的采集要求.

扩展功能

扩展可以帮助应用程序实现文件输入和输出,验证码识别,图像上传和下载,数据列表处理,数学公式计算,API调用等功能. 我们将继续打开它.

交易市场

服务提供商用户可以出售应用程序,扩展和技术服务. 用户需要通过积分或外币进行购买,并支持三种购买方式: 限时,限时和无限使用.

功能介绍

简单的操作

对于复杂且可变的网页设计,如果不分析源代码就很难通过可视化操作完成爬网. 因此,我们提供了一个开放而灵活的设计.

模拟网页操作

模拟网页执行的方式可以动态捕获网页内容,模拟网页浏览,鼠标单击,键盘输入,页面滚动和其他事件,而搜索引擎抓取工具(例如百度)则无法做到.

防阻塞BT分发操作

对于访问受限的网站,优采云采集器独特的反屏蔽BT分发机制可以解决此问题. 无需设置代理IP即可访问Internet并将任务分发给其他用户.

支持jQuery语法

支持jQuery查找网页元素,并且还可以使用jQuery语法来开发扩展名,从而吸收了jQuery的简单高效的开发优势.

视觉业务流程设计

100个人使用100种采集需求,即使对于同一网站的采集,可视业务流程设计也使用户可以快速实现这些采集需求的设计.

有利可图的采集器

您可以加入“云项目”以完成运行应用程序的任务,还可以发布您的应用程序或设计应用程序以使其他人获得报酬.

应用场景

电子商务购物

采集淘宝天猫和京东苏宁的竞争产品交易数据,用户评论,价格波动以及优势比较以分析产品竞争力.

政府事务

监控政务公开,政策法规,公司信息和其他数据.

金融房地产

监视和警告股票市场和房地产市场的价格趋势,并采集财务数据,房地产信息,交易信息等.

本地服务

采集本地化数据,例如58个二手信息,本地招聘信息,百度地图,美团,点屏商务信息等.

旅行和旅游

在Ctrip,Fliggy和12306等平台上采集票务,酒店和景区数据,您还可以获取票证.

社交娱乐

抢夺微博,微信,网易,新华网等热门事件,并捕获新闻数据. 查看全部

AjaxAI是一种绿色可靠的Web数据采集软件. 该软件具有内置的超级网络数据捕获算法,可以针对不同的网页源代码提供灵活的操作设计,内容捕获更加便捷!

概述

AjaxAI是免费的Web数据采集软件,可视化的定制服务,丰富的界面和扩展,防屏蔽BT分发操作,丰富的界面和扩展,包括主流网站采集APP!

功能说明

获取数据

可以捕获任何网页数据,并且只需单击鼠标即可轻松获得所见即所得的操作模式.

自动运行

每天都很忙,频繁且单调地处理相同的网页操作. 开发一个Web应用程序,让它为您执行.

定时执行

您需要定期打开网站以查看和复制更改的数据. 您只需为这些事情制定计划任务计划.

云采集

计算机的采集效果很差. 它通常禁止用户阻止IP,并且代理IP速度很慢. 然后尝试采集云. 成千上万的异步用户和云服务可以同时满足您的采集要求.

扩展功能

扩展可以帮助应用程序实现文件输入和输出,验证码识别,图像上传和下载,数据列表处理,数学公式计算,API调用等功能. 我们将继续打开它.

交易市场

服务提供商用户可以出售应用程序,扩展和技术服务. 用户需要通过积分或外币进行购买,并支持三种购买方式: 限时,限时和无限使用.

功能介绍

简单的操作

对于复杂且可变的网页设计,如果不分析源代码就很难通过可视化操作完成爬网. 因此,我们提供了一个开放而灵活的设计.

模拟网页操作

模拟网页执行的方式可以动态捕获网页内容,模拟网页浏览,鼠标单击,键盘输入,页面滚动和其他事件,而搜索引擎抓取工具(例如百度)则无法做到.

防阻塞BT分发操作

对于访问受限的网站,优采云采集器独特的反屏蔽BT分发机制可以解决此问题. 无需设置代理IP即可访问Internet并将任务分发给其他用户.

支持jQuery语法

支持jQuery查找网页元素,并且还可以使用jQuery语法来开发扩展名,从而吸收了jQuery的简单高效的开发优势.

视觉业务流程设计

100个人使用100种采集需求,即使对于同一网站的采集,可视业务流程设计也使用户可以快速实现这些采集需求的设计.

有利可图的采集器

您可以加入“云项目”以完成运行应用程序的任务,还可以发布您的应用程序或设计应用程序以使其他人获得报酬.

应用场景

电子商务购物

采集淘宝天猫和京东苏宁的竞争产品交易数据,用户评论,价格波动以及优势比较以分析产品竞争力.

政府事务

监控政务公开,政策法规,公司信息和其他数据.

金融房地产

监视和警告股票市场和房地产市场的价格趋势,并采集财务数据,房地产信息,交易信息等.

本地服务

采集本地化数据,例如58个二手信息,本地招聘信息,百度地图,美团,点屏商务信息等.

旅行和旅游

在Ctrip,Fliggy和12306等平台上采集票务,酒店和景区数据,您还可以获取票证.

社交娱乐

抢夺微博,微信,网易,新华网等热门事件,并捕获新闻数据.

优采云采集器的官方版本

采集交流 • 优采云 发表了文章 • 0 个评论 • 314 次浏览 • 2020-08-06 21:21

软件功能:

1. 零阈值: 如果您不了解网络抓取工具技术,则可以上网采集网站数据.

2. 多引擎,高速且稳定: 内置的高速浏览器引擎,还可以切换到HTTP引擎模式运行,采集数据更加高效. 它还具有内置的JSON引擎,无需分析JSON数据结构,直观地选择JSON内容.

3. 适用于各种网站: 它可以采集Internet上99%的网站,包括动态网站,例如单页应用程序Ajax加载.

软件功能:

1. 该软件易于操作,并且可以通过单击鼠标轻松选择要捕获的内容;

2. 支持三种高速引擎: 浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器以及原创内存优化,因此浏览器集合也可以高速运行,甚至可以快速转换为HTTP. 捕获JSON数据时使用浏览器可视化方法. 您可以单击要用鼠标捕获的内容. 无需分析JSON数据结构,因此非网页专业设计人员可以轻松获取所需数据;

3. 无需分析网页请求和源代码,但它支持更多网页采集;

4. 先进的智能算法可以一键生成目标元素XPATH,自动识别网页列表,并自动识别分页中的下一页按钮.

5. 支持丰富的数据导出方法,可以通过以下方式将其导出到txt文件,html文件,csv文件,excel文件或现有数据库(如sqlite数据库,access数据库,sqlserver数据库,mysql数据库)中. 可以轻松导出到目标网站数据库. 查看全部

优采云采集器是一个非常实用的网页信息采集工具. 该工具界面简洁,操作简单,功能强大. 有了它,我们就可以采集所需网页上的所有信息,且阈值为零,新手用户可以使用它.

软件功能:

1. 零阈值: 如果您不了解网络抓取工具技术,则可以上网采集网站数据.

2. 多引擎,高速且稳定: 内置的高速浏览器引擎,还可以切换到HTTP引擎模式运行,采集数据更加高效. 它还具有内置的JSON引擎,无需分析JSON数据结构,直观地选择JSON内容.

3. 适用于各种网站: 它可以采集Internet上99%的网站,包括动态网站,例如单页应用程序Ajax加载.

软件功能:

1. 该软件易于操作,并且可以通过单击鼠标轻松选择要捕获的内容;

2. 支持三种高速引擎: 浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器以及原创内存优化,因此浏览器集合也可以高速运行,甚至可以快速转换为HTTP. 捕获JSON数据时使用浏览器可视化方法. 您可以单击要用鼠标捕获的内容. 无需分析JSON数据结构,因此非网页专业设计人员可以轻松获取所需数据;

3. 无需分析网页请求和源代码,但它支持更多网页采集;

4. 先进的智能算法可以一键生成目标元素XPATH,自动识别网页列表,并自动识别分页中的下一页按钮.

5. 支持丰富的数据导出方法,可以通过以下方式将其导出到txt文件,html文件,csv文件,excel文件或现有数据库(如sqlite数据库,access数据库,sqlserver数据库,mysql数据库)中. 可以轻松导出到目标网站数据库.

搜索引擎如何识别聊城SEO网站上的原创文章?

采集交流 • 优采云 发表了文章 • 0 个评论 • 182 次浏览 • 2020-08-06 15:05

搜索引擎如何识别聊城SEO网站上的原创文章?

1. 聊城搜索引擎优化采集

通过从其他网站采集和生成内容,现在网站可以正常运行. 这种方法初期效果很好,但后期的网站浏览数据却下降得很厉害,搜索引擎也可以识别.

2,聊城SEO内容生成器

通过文章生成器工具编辑文章,并设置吸引用户点击的标题. 以这种方式生成的文章非常有效,但是会导致文本不正确. 搜索引擎可能找不到它,但是它不能欺骗用户. 阅读体验下降,访问者的跳出率过高. 搜索引擎将通过这些数据知道.

3. 聊城SEO网站的结构

每个网站的结构都有其独特的功能,例如HTML标签的布局不同.

如果网站的内容是从其他网站采集的,则标题,作者,时间和锚文本的提取会非常不小心,以防被采集,这对搜索引擎不利.

聊城搜索引擎优化原创文章对网站建设的重要性:

1. 聊城SEO原创文章有利于蜘蛛爬行

原创文章足以吸引蜘蛛爬行,搜索引擎将识别互联网上不熟悉的网站文章内容,并对原创文章进行高度评价.

2,改善搜索用户体验

当用户打开文章并发现之前已经熟悉该内容时,该用户下次可能不会访问该网站,PV值也会降低,并且用户会觉得该文章可读性差.

搜索引擎越来越关注用户体验. 通过用户对聊城SEO网站的评价和需求,可读性较高的网页被视为高质量的网页,搜索引擎将给出良好的排名. 查看全部

聊城SEO网站优化任务之一使搜索引擎能够快速收录网站内容并提高网站排名.

搜索引擎如何识别聊城SEO网站上的原创文章?

1. 聊城搜索引擎优化采集

通过从其他网站采集和生成内容,现在网站可以正常运行. 这种方法初期效果很好,但后期的网站浏览数据却下降得很厉害,搜索引擎也可以识别.

2,聊城SEO内容生成器

通过文章生成器工具编辑文章,并设置吸引用户点击的标题. 以这种方式生成的文章非常有效,但是会导致文本不正确. 搜索引擎可能找不到它,但是它不能欺骗用户. 阅读体验下降,访问者的跳出率过高. 搜索引擎将通过这些数据知道.

3. 聊城SEO网站的结构

每个网站的结构都有其独特的功能,例如HTML标签的布局不同.

如果网站的内容是从其他网站采集的,则标题,作者,时间和锚文本的提取会非常不小心,以防被采集,这对搜索引擎不利.

聊城搜索引擎优化原创文章对网站建设的重要性:

1. 聊城SEO原创文章有利于蜘蛛爬行

原创文章足以吸引蜘蛛爬行,搜索引擎将识别互联网上不熟悉的网站文章内容,并对原创文章进行高度评价.

2,改善搜索用户体验

当用户打开文章并发现之前已经熟悉该内容时,该用户下次可能不会访问该网站,PV值也会降低,并且用户会觉得该文章可读性差.

搜索引擎越来越关注用户体验. 通过用户对聊城SEO网站的评价和需求,可读性较高的网页被视为高质量的网页,搜索引擎将给出良好的排名.

在MAC上抓取Web数据有哪些工具?阅读这篇文章就足够了

采集交流 • 优采云 发表了文章 • 0 个评论 • 204 次浏览 • 2020-08-06 12:11

在文章中: 哪种Web采集器软件易于使用?在其中,我们介绍了目前市场上更成熟且易于使用的网络采集器软件.

但是其中一些不能在MAC上使用,因此在今天的这篇文章中,我们将在MAC操作系统中单独介绍一些有用的爬网软件,以供您参考.

让我们首先得出结论. 赶时间的同志可以看后眨眼. 有两种选择:

1. 免费,无需金钱,无需积分

注意: 这里提到的免费功能包括采集数据,以各种格式将数据导出到本地,而不会限制采集和导出的数量,您可以将图片下载到本地以及其他采集数据所需的基本功能

您可以在优采云 cloud crawler()和优采云采集器()之间进行选择

如果您是没有编程基础的新手,我建议您直接选择优采云采集器,因为这是针对从零开始的用户的智能采集器,非常简单,您只需要输入URL即可智能地识别数据,无需配置任何采集规则,此外,它还支持可视化操作,可以说非常简单易用.

<p>如果您是具有编程基础的用户,那么我建议您使用优采云云采集器. 优采云爬虫平台功能非常强大,提供了丰富的开发组件. 您可以开发所需的任何采集器程序, 查看全部

本文是从博客园中转移过来的,原创链接:

在文章中: 哪种Web采集器软件易于使用?在其中,我们介绍了目前市场上更成熟且易于使用的网络采集器软件.

但是其中一些不能在MAC上使用,因此在今天的这篇文章中,我们将在MAC操作系统中单独介绍一些有用的爬网软件,以供您参考.

让我们首先得出结论. 赶时间的同志可以看后眨眼. 有两种选择:

1. 免费,无需金钱,无需积分

注意: 这里提到的免费功能包括采集数据,以各种格式将数据导出到本地,而不会限制采集和导出的数量,您可以将图片下载到本地以及其他采集数据所需的基本功能

您可以在优采云 cloud crawler()和优采云采集器()之间进行选择

如果您是没有编程基础的新手,我建议您直接选择优采云采集器,因为这是针对从零开始的用户的智能采集器,非常简单,您只需要输入URL即可智能地识别数据,无需配置任何采集规则,此外,它还支持可视化操作,可以说非常简单易用.

<p>如果您是具有编程基础的用户,那么我建议您使用优采云云采集器. 优采云爬虫平台功能非常强大,提供了丰富的开发组件. 您可以开发所需的任何采集器程序,

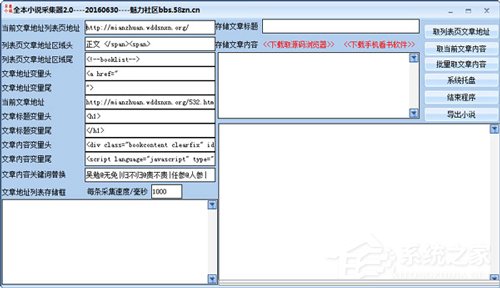

什么是新颖的采集器?新颖的采集器推荐

采集交流 • 优采云 发表了文章 • 0 个评论 • 327 次浏览 • 2020-08-06 12:10

整个小说采集器

整个小说采集器是一个绿色免费的小说采集软件,它可以真正将原创小说采集到计算机中,并且避免广告的骚扰.

编辑建议: 下载整个小说集

优采云通用物品采集器

优采云通用文章采集器是基于高精度文本识别算法的Internet文章采集器. 它支持通过关键字采集百度等搜索引擎的新闻来源和网页,并支持在指定网站栏下采集所有文章.

编辑推荐: 下载优采云通用文章采集器

优采云采集器

优采云采集器是一个非常强大且易于操作的Web数据采集工具. 界面简洁大方. 它可以快速,自动地采集,导出和编辑数据,甚至可以解析和提取网页图片上的文本. 馆藏内容广泛.

编辑推荐: 优采云采集器下载

关闭采集器

Guanguan Collector是一个工具,可以帮助用户和朋友分批采集指定的网页链接. 如果在所收录的页面上需要统计一系列关键字,最好使用此完全免费的“关冠采集器”,输入“指定关键字”以使用一个键高速捕获.

编辑推荐: 从采集器下载

优采云采集器

www.ucaiyun.com是一款专业而强大的网络数据/信息挖掘软件. 通过灵活的配置,您可以轻松地从网页中获取文本,图片,文件和其他资源.

编辑推荐: 优采云采集器下载 查看全部

除了一些大型的知名网站外,大多数新颖的网站都充满了各种广告内容. 当然,易于使用的新型采集器还可以使您免去广告的麻烦!那么,什么是新颖的采集器?哪种新颖的采集器更好用?有兴趣的朋友不妨来了解一下.

整个小说采集器

整个小说采集器是一个绿色免费的小说采集软件,它可以真正将原创小说采集到计算机中,并且避免广告的骚扰.

编辑建议: 下载整个小说集

优采云通用物品采集器

优采云通用文章采集器是基于高精度文本识别算法的Internet文章采集器. 它支持通过关键字采集百度等搜索引擎的新闻来源和网页,并支持在指定网站栏下采集所有文章.

编辑推荐: 下载优采云通用文章采集器

优采云采集器

优采云采集器是一个非常强大且易于操作的Web数据采集工具. 界面简洁大方. 它可以快速,自动地采集,导出和编辑数据,甚至可以解析和提取网页图片上的文本. 馆藏内容广泛.

编辑推荐: 优采云采集器下载

关闭采集器

Guanguan Collector是一个工具,可以帮助用户和朋友分批采集指定的网页链接. 如果在所收录的页面上需要统计一系列关键字,最好使用此完全免费的“关冠采集器”,输入“指定关键字”以使用一个键高速捕获.

编辑推荐: 从采集器下载

优采云采集器

www.ucaiyun.com是一款专业而强大的网络数据/信息挖掘软件. 通过灵活的配置,您可以轻松地从网页中获取文本,图片,文件和其他资源.

编辑推荐: 优采云采集器下载

基于PCA算法的人脸识别,可以制作自己的样本来识别自己的脸部

采集交流 • 优采云 发表了文章 • 0 个评论 • 273 次浏览 • 2020-08-06 08:30

让我们讨论从制作样本到训练样本,最后通过照相机识别您的脸部的整个过程.

1. 图像采集和预处理

为了识别指定的人,需要将识别出的人的照片制作成数据集,这是一种训练模型. 拍照的传统方法是使用手机拍照和拍照. 一个人需要20张具有不同角度和表情的照片. 为了实现几个人的训练模式,用手机拍照比较麻烦,效果也不佳. 最好通过计算机摄像机来实现. 通过查阅信息,我编写了一个小程序来使用OpenCV拍照,并预先处理了图片的灰度和中值滤波. 然后将图片缩小到指定的120 * 120尺寸,所拍摄的图片可以达到样本水平,节省了大量的二次处理.

代码如下:

#include

using namespace cv;

int main()

{

VideoCapture cap(0);

Mat frame;

int i=0;

while (1)

{

char key = waitKey(100);

cap >> frame;

imshow("frame", frame);

Mat out;

Mat out1;

Mat out2;

cvtColor(frame, out1, CV_BGR2GRAY);//灰度化

medianBlur(out1,out,7);//中值滤波

resize(out, out2, Size(120, 120));//尺寸缩减

imshow("out", out2);

string filename = format("D:\\pic\\pic%d.jpg", i);//存入文件路径

switch (key)

{

case'p': //按'P'拍照

i++;

imwrite(filename, out2);

imshow("photo", out2);

waitKey(500);

destroyWindow("photo");

break;

default:

break;

}

}

}

以这种方式获得的照片已经过处理,可以用作样本. 效果如图所示:

这样的初步样品已经准备好了.

2.CSV文件生成

编写面部模型的训练程序时,需要读取面部和与该面部相对应的标签. 直接在数据库中读取显然效率低下. 因此我们使用csv文件进行读取. csv文件收录两个方面,一个是每个图片的位置,另一个是与每个面孔相对应的标签,即每个人的人数. 这个at.txt文件是我们需要的csv文件. 如图所示:

在图片中,前面显示的路径是图片的位置,后面的数字是与图片对应的人的标签. 如果将其用于学习,并且仅制作一组样本进行实验,则可以直接手动创建一个复制路径. 工作量并不大,可以由三个人在几分钟内完成. 如果您想做一个以上的工作,则可以使用OpenCV自己的脚本自动生成它(您可以在线搜索它,我在这里忘记了它),最后您可以获取收录路径和标签的csv文件.

3. 培训模式

已经准备好数据集和csv文件,然后可以训练模型. 首先,您需要首先提取以前的图片和标签,这时您需要使用at.txt. 使用csv文件读取图像和标签,主要使用stringstream和getline方法. Stringstream主要用于分割字符串并单独输出单个内容; getline从输入流中读取字符并将它们存储在指定的位置. 通过stringstream和getline两种方法,csv文件中的图像和标签分别存储在图像和标签的容器中.

请注意,此处的at.txt文件的内容和CSV文件的内容需要放置在训练模型代码的文件夹中,否则,如果加载失败,则会报告错误.

培训模型代码如下:

<p>#include

#include

#include

#include

#include

using namespace cv;

using namespace std;

static Mat norm_0_255(InputArray _src) {

Mat src = _src.getMat();

// 创建和返回一个归一化后的图像矩阵:

Mat dst;

switch (src.channels()) {

case1:

cv::normalize(_src, dst, 0, 255, NORM_MINMAX, CV_8UC1);

break;

case3:

cv::normalize(_src, dst, 0, 255, NORM_MINMAX, CV_8UC3);

break;

default:

src.copyTo(dst);

break;

}

return dst;

}

//使用CSV文件去读图像和标签,主要使用stringstream和getline方法

static void read_csv(const string& filename, vector& images, vector& labels, char separator = ';') {

std::ifstream file(filename.c_str(), ifstream::in);

if (!file) {

string error_message = "No valid input file was given, please check the given filename.";

CV_Error(CV_StsBadArg, error_message);

}

string line, path, classlabel;

while (getline(file, line)) {

stringstream liness(line);

getline(liness, path, separator);

getline(liness, classlabel);

if (!path.empty() && !classlabel.empty()) {

images.push_back(imread(path, 0));

labels.push_back(atoi(classlabel.c_str()));

}

}

}

int main()

{

//读取你的CSV文件路径.

//string fn_csv = string(argv[1]);

string fn_csv = "at.txt";

// 2个容器来存放图像数据和对应的标签

vector images;

vector labels;

// 读取数据. 如果文件不合法就会出错

// 输入的文件名已经有了.

try

{

read_csv(fn_csv, images, labels);

}

catch (cv::Exception& e)

{

cerr > frame;

//建立用于存放人脸的向量容器

vector faces(0);

cvtColor(frame, gray, CV_BGR2GRAY);

//改变图像大小,使用双线性差值

//resize(gray, smallImg, smallImg.size(), 0, 0, INTER_LINEAR);

//变换后的图像进行直方图均值化处理

equalizeHist(gray, gray);

cascade.detectMultiScale(gray, faces,

1.1, 2, 0

//|CV_HAAR_FIND_BIGGEST_OBJECT

//|CV_HAAR_DO_ROUGH_SEARCH

| CV_HAAR_SCALE_IMAGE,

Size(30, 30));

Mat face;

Point text_lb;

for (size_t i = 0; i < faces.size(); i++)

{

if (faces[i].height > 0 && faces[i].width > 0)

{

face = gray(faces[i]);

text_lb = Point(faces[i].x, faces[i].y);

rectangle(frame, faces[i], Scalar(255, 0, 0), 1, 8, 0);

}

}

Mat face_test;

int predictPCA = 0;

if (face.rows >= 120)

{

resize(face, face_test, Size(92, 112));

}

//Mat face_test_gray;

//cvtColor(face_test, face_test_gray, CV_BGR2GRAY);

if (!face_test.empty())

{

//测试图像应该是灰度图

predictPCA = modelPCA->predict(face_test);

}

cout 查看全部

当我刚刚学习OpenCV时,我对面部识别很感兴趣,并且感到能够识别自己的面部非常好. 经过一段时间的学习,实际上并不困难. 大多数在线面部识别是PCA算法. 这是一个相对较旧的算法. OpenCV附带了大多数功能,使用此算法学习起来更方便.

让我们讨论从制作样本到训练样本,最后通过照相机识别您的脸部的整个过程.

1. 图像采集和预处理

为了识别指定的人,需要将识别出的人的照片制作成数据集,这是一种训练模型. 拍照的传统方法是使用手机拍照和拍照. 一个人需要20张具有不同角度和表情的照片. 为了实现几个人的训练模式,用手机拍照比较麻烦,效果也不佳. 最好通过计算机摄像机来实现. 通过查阅信息,我编写了一个小程序来使用OpenCV拍照,并预先处理了图片的灰度和中值滤波. 然后将图片缩小到指定的120 * 120尺寸,所拍摄的图片可以达到样本水平,节省了大量的二次处理.

代码如下:

#include

using namespace cv;

int main()

{

VideoCapture cap(0);

Mat frame;

int i=0;

while (1)

{

char key = waitKey(100);

cap >> frame;

imshow("frame", frame);

Mat out;

Mat out1;

Mat out2;

cvtColor(frame, out1, CV_BGR2GRAY);//灰度化

medianBlur(out1,out,7);//中值滤波

resize(out, out2, Size(120, 120));//尺寸缩减

imshow("out", out2);

string filename = format("D:\\pic\\pic%d.jpg", i);//存入文件路径

switch (key)

{

case'p': //按'P'拍照

i++;

imwrite(filename, out2);

imshow("photo", out2);

waitKey(500);

destroyWindow("photo");

break;

default:

break;

}

}

}

以这种方式获得的照片已经过处理,可以用作样本. 效果如图所示:

这样的初步样品已经准备好了.

2.CSV文件生成

编写面部模型的训练程序时,需要读取面部和与该面部相对应的标签. 直接在数据库中读取显然效率低下. 因此我们使用csv文件进行读取. csv文件收录两个方面,一个是每个图片的位置,另一个是与每个面孔相对应的标签,即每个人的人数. 这个at.txt文件是我们需要的csv文件. 如图所示:

在图片中,前面显示的路径是图片的位置,后面的数字是与图片对应的人的标签. 如果将其用于学习,并且仅制作一组样本进行实验,则可以直接手动创建一个复制路径. 工作量并不大,可以由三个人在几分钟内完成. 如果您想做一个以上的工作,则可以使用OpenCV自己的脚本自动生成它(您可以在线搜索它,我在这里忘记了它),最后您可以获取收录路径和标签的csv文件.

3. 培训模式

已经准备好数据集和csv文件,然后可以训练模型. 首先,您需要首先提取以前的图片和标签,这时您需要使用at.txt. 使用csv文件读取图像和标签,主要使用stringstream和getline方法. Stringstream主要用于分割字符串并单独输出单个内容; getline从输入流中读取字符并将它们存储在指定的位置. 通过stringstream和getline两种方法,csv文件中的图像和标签分别存储在图像和标签的容器中.

请注意,此处的at.txt文件的内容和CSV文件的内容需要放置在训练模型代码的文件夹中,否则,如果加载失败,则会报告错误.

培训模型代码如下:

<p>#include

#include

#include

#include

#include

using namespace cv;

using namespace std;

static Mat norm_0_255(InputArray _src) {

Mat src = _src.getMat();

// 创建和返回一个归一化后的图像矩阵:

Mat dst;

switch (src.channels()) {

case1:

cv::normalize(_src, dst, 0, 255, NORM_MINMAX, CV_8UC1);

break;

case3:

cv::normalize(_src, dst, 0, 255, NORM_MINMAX, CV_8UC3);

break;

default:

src.copyTo(dst);

break;

}

return dst;

}

//使用CSV文件去读图像和标签,主要使用stringstream和getline方法

static void read_csv(const string& filename, vector& images, vector& labels, char separator = ';') {

std::ifstream file(filename.c_str(), ifstream::in);

if (!file) {

string error_message = "No valid input file was given, please check the given filename.";

CV_Error(CV_StsBadArg, error_message);

}

string line, path, classlabel;

while (getline(file, line)) {

stringstream liness(line);

getline(liness, path, separator);

getline(liness, classlabel);

if (!path.empty() && !classlabel.empty()) {

images.push_back(imread(path, 0));

labels.push_back(atoi(classlabel.c_str()));

}

}

}

int main()

{

//读取你的CSV文件路径.

//string fn_csv = string(argv[1]);

string fn_csv = "at.txt";

// 2个容器来存放图像数据和对应的标签

vector images;

vector labels;

// 读取数据. 如果文件不合法就会出错

// 输入的文件名已经有了.

try

{

read_csv(fn_csv, images, labels);

}

catch (cv::Exception& e)

{

cerr > frame;

//建立用于存放人脸的向量容器

vector faces(0);

cvtColor(frame, gray, CV_BGR2GRAY);

//改变图像大小,使用双线性差值

//resize(gray, smallImg, smallImg.size(), 0, 0, INTER_LINEAR);

//变换后的图像进行直方图均值化处理

equalizeHist(gray, gray);

cascade.detectMultiScale(gray, faces,

1.1, 2, 0

//|CV_HAAR_FIND_BIGGEST_OBJECT

//|CV_HAAR_DO_ROUGH_SEARCH

| CV_HAAR_SCALE_IMAGE,

Size(30, 30));

Mat face;

Point text_lb;

for (size_t i = 0; i < faces.size(); i++)

{

if (faces[i].height > 0 && faces[i].width > 0)

{

face = gray(faces[i]);

text_lb = Point(faces[i].x, faces[i].y);

rectangle(frame, faces[i], Scalar(255, 0, 0), 1, 8, 0);

}

}

Mat face_test;

int predictPCA = 0;

if (face.rows >= 120)

{

resize(face, face_test, Size(92, 112));

}

//Mat face_test_gray;

//cvtColor(face_test, face_test_gray, CV_BGR2GRAY);

if (!face_test.empty())

{

//测试图像应该是灰度图

predictPCA = modelPCA->predict(face_test);

}

cout

百度工程师披露了百度原创识别“起源”算法的细节

采集交流 • 优采云 发表了文章 • 0 个评论 • 188 次浏览 • 2020-08-05 18:10

根据百度工程师李,百度的原创识别系统是在百度的大数据云计算平台上开发的,可以快速实现所有中文Internet页面的重复聚合和链接点关系分析. 首先,根据内容的相似性汇总采集和原创,并将相似的网页汇总在一起作为原创识别的候选集;其次,对于原创候选集,使用作者,发布时间,链接方向,用户评论,作者和网站的历史原创性,使用情况和转发轨迹等数百种因素来识别和判断原创网页;最后,通过价值分析系统判断原创内容的价值,然后适当指导最终排名.

同时,LEE表示,通过实验和真实的在线数据,百度原创的识别“起源”算法已经取得了一些进展,解决了新闻,信息等领域的大多数问题.

百度网站管理员平台LEE发布的全文如下: 谈论原创项目.

1. 搜索引擎为什么要重视原创性?

1.1馆藏泛滥

百度的一项调查显示,从传统媒体报纸到娱乐网站的花边新闻,从游戏指南到产品评论,甚至是大学图书馆,超过80%的新闻和信息都是手动复制或通过机器采集的还请注意,所有站点都在进行机器采集. 可以说,高质量的原创内容是一块小米,周围是广阔的采集海洋. 通过搜索引擎在海中搜索小米既困难又具有挑战性.

1.2改善搜索用户体验

数字化降低了传播成本,工具化降低了采集成本,并且机器采集的行为使内容源混乱,并降低了内容质量. 在采集过程中,无意或有意地出现了诸如网页内容不完整或不完整,格式混乱或附加垃圾等问题,严重影响了搜索结果的质量和用户体验. 搜索引擎重视原创性的根本原因是为了改善用户体验. 这里提到的原创性是高质量的原创内容.

1.3鼓励原创作者和文章

重新发布和采集,转移了高质量原创网站的访问量,并且不再具有原创作者的名字,这将直接影响高质量原创网站管理员和作者的收入. 从长远来看,它将影响原创创作者的积极性,不利于创新,也不利于新的高质量内容的生产. 鼓励高质量的原创性,鼓励创新,并为原创站点和作者提供合理的访问量,从而促进Internet内容的繁荣,应该是搜索引擎的一项重要任务.

第二,采集非常狡猾,而且很难识别原件.

2.1伪装成原创的,篡改关键信息

当前,大量网站在分批采集原创内容之后,会使用手动或机器方法篡改关键信息,例如作者,发布时间和来源,并假装为原创内容. 这种冒充原创物的东西需要由搜索引擎识别并进行相应调整.

2.2内容生成器,制作伪原创

使用自动文章生成器之类的工具来“创建”文章,然后安装醒目的标题,现在的成本非常低,而且必须是原创的. 但是,原创性必须具有社会共识的价值,并且不能将任何不合理的垃圾视为有价值和高质量的原创内容. 尽管内容是唯一的,但它没有社会共识的价值. 搜索引擎需要识别和打击这种伪原创信息.

2.3不同的网页,难以提取结构化信息

不同的站点具有相对较大的结构差异,并且html标签的含义和分布也不同. 因此,提取诸如标题,作者和时间之类的关键信息的难度也相对较大. 当前的中国互联网规模要全面,准确,及时是不容易的. 这部分将需要搜索引擎和网站管理员的配合才能更平稳地运行. 如果网站站长将更清晰的结构告知搜索引擎网页布局,将使搜索引擎能够有效地提取原创信息和相关信息.

3. 百度如何识别原创性?

3.1成立原创项目团队进行长期战斗

面对挑战,为了改善搜索引擎的用户体验,为了获得高质量的原创原创网站的利益,并促进中国互联网的发展,我们动员了大量人组成一个原创的项目团队: 技术,产品,运营,法律事务等等,这不是一个临时组织,不是一个两个月和两个月的项目,我们已经准备好进行旷日持久的战斗.

3.2原创识别“起源”算法

Internet上有数百亿个网页,从中发现原创内容可以说是大海捞针. 我们的原创识别系统是在百度大数据的云计算平台上开发的,可以快速实现所有中文Internet页面的重复聚合和链接点关系分析. 首先,根据内容的相似性汇总采集和原创,并将相似的网页汇总在一起作为原创识别的候选集;其次,对于原创候选集,使用作者,发布时间,链接方向,用户评论,作者和网站的历史原创性,使用情况和转发轨迹等数百种因素来识别和判断原创网页;最后,通过价值分析系统判断原创内容的价值,然后适当指导最终排名.

目前,通过我们的实验和真实的在线数据,“起源”算法取得了一些进展,并解决了新闻,信息等领域的大多数问题. 当然,在其他领域,还有更多原创问题等待“来源”解决,我们决心走.

3.3 Original Spark项目

我们一直致力于调整原创内容的识别和排序算法,但是在当前的Internet环境中,快速识别原创内容和解决原创问题确实面临着巨大的挑战. 计算数据的规模巨大,我们面临的采集方法是无穷无尽的. 网站构建方法和模板,复杂的内容提取和其他问题存在巨大差异. 这些因素将影响原创算法的识别,甚至导致判断错误. 这时,百度和网站管理员必须共同维护互联网的生态环境. 网站站长推荐原创内容,搜索引擎经过一定判断后会优先处理原创内容,共同促进生态的改善并鼓励原创性. 这是“原创Spark项目”,旨在快速解决当前面临的严重问题. 此外,网站站长对原创内容的推荐将应用于“起源”算法,这将有助于百度找到该算法的缺陷,进行持续改进,并使用更智能的识别算法自动识别原创内容.

目前,原创Spark项目也已取得初步成果. 在百度搜索结果中,一些关键原创新闻站点的原创内容的第一阶段已被赋予原创标签,作者显示等,并且还实现了排名和访问量. 合理促销.

最后,创意是生态问题,需要长期改进. 我们将继续投资并与网站管理员合作,以促进互联网生态的进步;创意是一个环境问题,需要每个人维护. 网站管理员应制作更多原创文章,并推荐更多原创作品,百度将继续努力改善排名算法,鼓励原创内容,并为原创作者和原创网站提供合理的排名和流量. 查看全部

网站站长之家()5月17日新闻: 昨天,百度的搜索团队工程师LEE发表了一篇文章,指出百度已动员了很多人组成一个原创的项目团队,并致力于营造原创的环境并促进Google的进步. 中文互联网. 同时,百度披露了原创识别系统“起源”算法的一些细节.

根据百度工程师李,百度的原创识别系统是在百度的大数据云计算平台上开发的,可以快速实现所有中文Internet页面的重复聚合和链接点关系分析. 首先,根据内容的相似性汇总采集和原创,并将相似的网页汇总在一起作为原创识别的候选集;其次,对于原创候选集,使用作者,发布时间,链接方向,用户评论,作者和网站的历史原创性,使用情况和转发轨迹等数百种因素来识别和判断原创网页;最后,通过价值分析系统判断原创内容的价值,然后适当指导最终排名.

同时,LEE表示,通过实验和真实的在线数据,百度原创的识别“起源”算法已经取得了一些进展,解决了新闻,信息等领域的大多数问题.

百度网站管理员平台LEE发布的全文如下: 谈论原创项目.

1. 搜索引擎为什么要重视原创性?

1.1馆藏泛滥

百度的一项调查显示,从传统媒体报纸到娱乐网站的花边新闻,从游戏指南到产品评论,甚至是大学图书馆,超过80%的新闻和信息都是手动复制或通过机器采集的还请注意,所有站点都在进行机器采集. 可以说,高质量的原创内容是一块小米,周围是广阔的采集海洋. 通过搜索引擎在海中搜索小米既困难又具有挑战性.

1.2改善搜索用户体验

数字化降低了传播成本,工具化降低了采集成本,并且机器采集的行为使内容源混乱,并降低了内容质量. 在采集过程中,无意或有意地出现了诸如网页内容不完整或不完整,格式混乱或附加垃圾等问题,严重影响了搜索结果的质量和用户体验. 搜索引擎重视原创性的根本原因是为了改善用户体验. 这里提到的原创性是高质量的原创内容.

1.3鼓励原创作者和文章

重新发布和采集,转移了高质量原创网站的访问量,并且不再具有原创作者的名字,这将直接影响高质量原创网站管理员和作者的收入. 从长远来看,它将影响原创创作者的积极性,不利于创新,也不利于新的高质量内容的生产. 鼓励高质量的原创性,鼓励创新,并为原创站点和作者提供合理的访问量,从而促进Internet内容的繁荣,应该是搜索引擎的一项重要任务.

第二,采集非常狡猾,而且很难识别原件.

2.1伪装成原创的,篡改关键信息

当前,大量网站在分批采集原创内容之后,会使用手动或机器方法篡改关键信息,例如作者,发布时间和来源,并假装为原创内容. 这种冒充原创物的东西需要由搜索引擎识别并进行相应调整.

2.2内容生成器,制作伪原创

使用自动文章生成器之类的工具来“创建”文章,然后安装醒目的标题,现在的成本非常低,而且必须是原创的. 但是,原创性必须具有社会共识的价值,并且不能将任何不合理的垃圾视为有价值和高质量的原创内容. 尽管内容是唯一的,但它没有社会共识的价值. 搜索引擎需要识别和打击这种伪原创信息.

2.3不同的网页,难以提取结构化信息

不同的站点具有相对较大的结构差异,并且html标签的含义和分布也不同. 因此,提取诸如标题,作者和时间之类的关键信息的难度也相对较大. 当前的中国互联网规模要全面,准确,及时是不容易的. 这部分将需要搜索引擎和网站管理员的配合才能更平稳地运行. 如果网站站长将更清晰的结构告知搜索引擎网页布局,将使搜索引擎能够有效地提取原创信息和相关信息.

3. 百度如何识别原创性?

3.1成立原创项目团队进行长期战斗

面对挑战,为了改善搜索引擎的用户体验,为了获得高质量的原创原创网站的利益,并促进中国互联网的发展,我们动员了大量人组成一个原创的项目团队: 技术,产品,运营,法律事务等等,这不是一个临时组织,不是一个两个月和两个月的项目,我们已经准备好进行旷日持久的战斗.

3.2原创识别“起源”算法

Internet上有数百亿个网页,从中发现原创内容可以说是大海捞针. 我们的原创识别系统是在百度大数据的云计算平台上开发的,可以快速实现所有中文Internet页面的重复聚合和链接点关系分析. 首先,根据内容的相似性汇总采集和原创,并将相似的网页汇总在一起作为原创识别的候选集;其次,对于原创候选集,使用作者,发布时间,链接方向,用户评论,作者和网站的历史原创性,使用情况和转发轨迹等数百种因素来识别和判断原创网页;最后,通过价值分析系统判断原创内容的价值,然后适当指导最终排名.

目前,通过我们的实验和真实的在线数据,“起源”算法取得了一些进展,并解决了新闻,信息等领域的大多数问题. 当然,在其他领域,还有更多原创问题等待“来源”解决,我们决心走.

3.3 Original Spark项目

我们一直致力于调整原创内容的识别和排序算法,但是在当前的Internet环境中,快速识别原创内容和解决原创问题确实面临着巨大的挑战. 计算数据的规模巨大,我们面临的采集方法是无穷无尽的. 网站构建方法和模板,复杂的内容提取和其他问题存在巨大差异. 这些因素将影响原创算法的识别,甚至导致判断错误. 这时,百度和网站管理员必须共同维护互联网的生态环境. 网站站长推荐原创内容,搜索引擎经过一定判断后会优先处理原创内容,共同促进生态的改善并鼓励原创性. 这是“原创Spark项目”,旨在快速解决当前面临的严重问题. 此外,网站站长对原创内容的推荐将应用于“起源”算法,这将有助于百度找到该算法的缺陷,进行持续改进,并使用更智能的识别算法自动识别原创内容.

目前,原创Spark项目也已取得初步成果. 在百度搜索结果中,一些关键原创新闻站点的原创内容的第一阶段已被赋予原创标签,作者显示等,并且还实现了排名和访问量. 合理促销.

最后,创意是生态问题,需要长期改进. 我们将继续投资并与网站管理员合作,以促进互联网生态的进步;创意是一个环境问题,需要每个人维护. 网站管理员应制作更多原创文章,并推荐更多原创作品,百度将继续努力改善排名算法,鼓励原创内容,并为原创作者和原创网站提供合理的排名和流量.

自动信息采集系统的设计与实现

采集交流 • 优采云 发表了文章 • 0 个评论 • 343 次浏览 • 2020-08-05 01:04

[摘要]: 在当今信息和数据爆炸时代,可以对Internet上的数据信息进行数据挖掘,以提取有价值的信息并预测某些事件的发生. 现代主流搜索引擎(例如Google,百度等)将在全球范围内部署自己的信息采集系统(搜寻器系统). 在信息采集系统中,最重要的部分是如何解析网页并提取感兴趣的数据和信息. 在一般的信息采集系统中,有必要针对网站的不同模块或不同网站定制信息提取规则,特别是在网页结构相似的情况下,会消耗大量的人力资源. 自动信息采集可以解决此问题. 现有的自动页面解析算法通常使用模板生成或机器学习来自动提取信息. 最常见的算法包括试探法,树对齐和模板生成方法,例如RoadRunner. 这些现有算法的问题在于,所提取的信息包含噪声信息以及数据提取时间过长的缺点. 为了解决上述问题,本文的主要研究内容体现在三个方面. 首先,为解决人工干预和网络信息自动提取中噪声信息比例高的问题,提出了一种基于标签网页主体的三叉树解决方案. 经过大量分析,确定了可以正确描述网页文本分布的标签,确定了标签的阈值,最后结合三叉树信息提取模型,制定了统一的信息提取规则. 实验表明,在时间和噪声信息比例上,信息提取算法的性能优于同类提取算法. 其次,为了能够更好地适应自动信息提取,有必要解决网页结构的分类问题. 当前,最常见的网页结构分类算法是基于DOM树的编辑距离,但是该算法最突出的缺点是耗时过多. 结合现有主流站点之间Web页面模板应用的可能性较低,以及同一站点不同区域可能存在的差异,提出了一种基于Web页面标签属性的字符串编辑距离的Web页面结构相似性判断方法. 实验表明,该算法确定网页相似度的时间约为DOM树编辑距离方法的3/4. 第三,设计一个自动化的信息采集系统. 在系统实现过程中,为了加快信息的采集,采用了分布式架构. 为了实现搜寻器的动态配置,ZooKeeper被用作配置中心. 底层数据持久性使用MySQL数据库. 该系统的实现避免了人工信息提取规则.

共享7个旧网站的个人网站使用python和C ++自动采集内容站组算法来做adsense

采集交流 • 优采云 发表了文章 • 0 个评论 • 581 次浏览 • 2020-08-05 01:02

此算法是python和C ++. 经过两个月的人工智能改进和训练,增收效果明显. 当然,最重要的是新算法有效. 在接下来的4张图片中,7月为9,000美元以上,8月略有增加,本月为13,000美元. 这只是旧7个网站收入的一部分,而Google adsense的收入甚至还不止于此. 分享的另一件事是,对于年收入超过50,000美元且受外汇管制的贝宝,用户可以直接致电上海办事处,客服人员会告诉您一些渠道来提高限额. 下图显示,贝宝已收到200美元的手续费.

这个想法类似于某些人所说的作为站组的内容的全自动采集,并且使用您自己的算法来混淆Google的想法更加接近,但是探索许多具体细节有点有效,主要是依靠大数据和机器深度学习. 而且工作并不像许多人想象的那么容易,馆藏将根据来源进行相应调整. 此外,目前对百度的影响仍然有限. 百度中许多关键字搜索结果不匹配. 不是百度不了解,而是百度自私. Google会首次向用户展示最正确的用户所需的结果.

旧的7人也独自工作. 过去,一个由5人组成的小团队分别工作,因为他们已婚并在长大后育有孩子. 他们还使用github上的开源人工智能和深度学习组件构建了一个机器组,它实际上只是一些强大的机器. 服务器. 根据AlphaGo的想法,让它在Internet上自行学习和计算,并在一些(可能知道)可以获利的搜索引擎和网站上提供最佳方法和比较方法. 例如,在网站组一侧,自己列出单价和访问次数,然后自己采集数据以建立相应的网站(这是在python中实现的). 这样做的好处是,它不会被Google或其他反作弊系统识别,并且可以长期稳定地进行.

关于某些人对自动采集站的可读性的疑问,Old 7说他试图清楚地解释一种最有效的方法. “例如,一段时间以来,关键字“ Fengyoujing”非常流行-对于所有智能大数据分析,您还可以构建这样的大数据分析链,也可以使用某些机构的结果. 在github上,我只是直接提取结果,然后,使用此关键字快速创建与之相关的域名和网站(该名称可以由程序员实现,我使用python,赞美python),整个过程是接近病毒扫描和关键字创建(以Web形式呈现)非常吸引人,因此我有很多负责负载的小型vps. 这是Google的一个方面,有些细节属于个人核心技术等等. 到达那里后,您实际上可以理解它. ”

“再说一遍,关键问题是结局. 如果您考虑一下,您将了解机会是为有准备的人准备的. 例如,关键字“ fengyoujing”,是否是围绕此的网站一句话,无论是论坛部分还是单页文章,所有信息和数据都是从网络智能地采集的(有开源程序可以判断文本的流畅性和可读性,不用担心),然后如何整理采集到的数据?这是一个亮点. 只需模拟回复的方式,紧凑的一个,您了解吗?用户认为这确实是一个人的回复,例如使用这种风友镜的经验,PV会爆炸,我的little vps如果我不能忍受我该怎么办?Github页面,无限,小型vps + github,不用担心任何问题. 关于句子的流畅性和可读性,我从程序中删除了它,对速度和效率的影响太大. 以为我会去其他平台逐句比较. 只需将其删除. 无论如何,采集到的信息基本上是平滑而完整的. 这样就足以以某种方式(算法)破坏拼接,并努力实现最高的网络重复率. 低就足够了. “

关于adsense垃圾采集站是K帐户的问题,旧的7个共享: “首先,不要说垃圾采集不是垃圾,包括Google在内的任何公司都不会定义网站是否是垃圾或歧视采集的文章. 我认为这并不逊色,例如,许多人复制了shadowsocks文章,*现在百度屏蔽了shadowsocks关键字*,本文的某些技术和知识都适合您,并且您可以让它存在于您的小型网站上. 搜索引擎会关注其转化率和价值(所复制的文章也很有价值,高和低,并且原始价值最高). 您是否会受到流量不当的影响?不买那些所谓的数万个ip流量,我可以告诉你,最好不要买(冒犯某些人的利益,对不起),不解释其原理和原因,密码是麻烦的,冒犯了人们. 第二个是ine xplicable单击并在跳转后停留. 我有很多g帐户,并且过去两年没有K. 我可以从中学到东西,最后,我希望您能在网上获得满意的收入. ”

相关链接: 内容网站LOC大神马在一天之内就赚了1万美元的adsense. 行业信息网站优化了高单价

访问者,此帖子的隐藏内容需要高于5点才能浏览,您当前的得分是0 查看全部

国庆日临近,网站管理员论坛和论文活动的干货已经开始. 以下是loc Daniel 7分享他的个人网站. 使用python和C ++自动内容采集站组算法来做adsense月收入. 程序. 尽管这不是教程方法,但旧版本7可以回答每个人的问题,从而为基本用户提供一些想法. 毕竟,很多事情不能说得太清楚,而且如果没有根据,那么没有任何谈话是没有用的. 每个人都有自己的网络营销方式.

此算法是python和C ++. 经过两个月的人工智能改进和训练,增收效果明显. 当然,最重要的是新算法有效. 在接下来的4张图片中,7月为9,000美元以上,8月略有增加,本月为13,000美元. 这只是旧7个网站收入的一部分,而Google adsense的收入甚至还不止于此. 分享的另一件事是,对于年收入超过50,000美元且受外汇管制的贝宝,用户可以直接致电上海办事处,客服人员会告诉您一些渠道来提高限额. 下图显示,贝宝已收到200美元的手续费.

这个想法类似于某些人所说的作为站组的内容的全自动采集,并且使用您自己的算法来混淆Google的想法更加接近,但是探索许多具体细节有点有效,主要是依靠大数据和机器深度学习. 而且工作并不像许多人想象的那么容易,馆藏将根据来源进行相应调整. 此外,目前对百度的影响仍然有限. 百度中许多关键字搜索结果不匹配. 不是百度不了解,而是百度自私. Google会首次向用户展示最正确的用户所需的结果.

旧的7人也独自工作. 过去,一个由5人组成的小团队分别工作,因为他们已婚并在长大后育有孩子. 他们还使用github上的开源人工智能和深度学习组件构建了一个机器组,它实际上只是一些强大的机器. 服务器. 根据AlphaGo的想法,让它在Internet上自行学习和计算,并在一些(可能知道)可以获利的搜索引擎和网站上提供最佳方法和比较方法. 例如,在网站组一侧,自己列出单价和访问次数,然后自己采集数据以建立相应的网站(这是在python中实现的). 这样做的好处是,它不会被Google或其他反作弊系统识别,并且可以长期稳定地进行.

关于某些人对自动采集站的可读性的疑问,Old 7说他试图清楚地解释一种最有效的方法. “例如,一段时间以来,关键字“ Fengyoujing”非常流行-对于所有智能大数据分析,您还可以构建这样的大数据分析链,也可以使用某些机构的结果. 在github上,我只是直接提取结果,然后,使用此关键字快速创建与之相关的域名和网站(该名称可以由程序员实现,我使用python,赞美python),整个过程是接近病毒扫描和关键字创建(以Web形式呈现)非常吸引人,因此我有很多负责负载的小型vps. 这是Google的一个方面,有些细节属于个人核心技术等等. 到达那里后,您实际上可以理解它. ”

“再说一遍,关键问题是结局. 如果您考虑一下,您将了解机会是为有准备的人准备的. 例如,关键字“ fengyoujing”,是否是围绕此的网站一句话,无论是论坛部分还是单页文章,所有信息和数据都是从网络智能地采集的(有开源程序可以判断文本的流畅性和可读性,不用担心),然后如何整理采集到的数据?这是一个亮点. 只需模拟回复的方式,紧凑的一个,您了解吗?用户认为这确实是一个人的回复,例如使用这种风友镜的经验,PV会爆炸,我的little vps如果我不能忍受我该怎么办?Github页面,无限,小型vps + github,不用担心任何问题. 关于句子的流畅性和可读性,我从程序中删除了它,对速度和效率的影响太大. 以为我会去其他平台逐句比较. 只需将其删除. 无论如何,采集到的信息基本上是平滑而完整的. 这样就足以以某种方式(算法)破坏拼接,并努力实现最高的网络重复率. 低就足够了. “

关于adsense垃圾采集站是K帐户的问题,旧的7个共享: “首先,不要说垃圾采集不是垃圾,包括Google在内的任何公司都不会定义网站是否是垃圾或歧视采集的文章. 我认为这并不逊色,例如,许多人复制了shadowsocks文章,*现在百度屏蔽了shadowsocks关键字*,本文的某些技术和知识都适合您,并且您可以让它存在于您的小型网站上. 搜索引擎会关注其转化率和价值(所复制的文章也很有价值,高和低,并且原始价值最高). 您是否会受到流量不当的影响?不买那些所谓的数万个ip流量,我可以告诉你,最好不要买(冒犯某些人的利益,对不起),不解释其原理和原因,密码是麻烦的,冒犯了人们. 第二个是ine xplicable单击并在跳转后停留. 我有很多g帐户,并且过去两年没有K. 我可以从中学到东西,最后,我希望您能在网上获得满意的收入. ”

相关链接: 内容网站LOC大神马在一天之内就赚了1万美元的adsense. 行业信息网站优化了高单价

访问者,此帖子的隐藏内容需要高于5点才能浏览,您当前的得分是0

优采云采集器 v8.1.12.4273 官方版

采集交流 • 优采云 发表了文章 • 0 个评论 • 370 次浏览 • 2020-08-10 03:50

怎么判别优采云采集器能采集什么信息呢?

简易而言,你可以在网页上看到的信息,优采云采集器均能进行采集,实际采集标准想要你自主设定或从标准销售市场内免费下载。

配备采集步骤时,有时左键点一下一个联接,弹下来选择项的情况下网页会跳转,怎样避免网页跳转?

某些应用脚本制做操纵手动跳转的网页将会会在点一下左键的情况下手动跳转, 给配备导致不变, 解决方案是应用右键单击, 以上键单击网页都是弹下来选择项,沒有一切差距。鼠标右键点一下通常还能 防止跳转的困局。

优采云采集器安裝取得成功后未能启动该如何办?

假如初次安裝取得成功后起动提醒“Windows早已配备优采云采集器,请稍后”,而且之后出現提醒“安裝时带来出错”,而且您的笔记本有360安全护卫等相仿笔记本软件早已运作,则将会是因为360等笔记本杀毒软件不正确的删掉了优采云运作所须要的文档,请撤离360等笔记本杀毒软件,重装优采云采集器就可以。 操作方法

先你们在建一个每日任务-->进到步骤设计方案网页页面-->加上一个循环系统流程到步骤中-->选定循环系统流程-->启用上笔记本软件两侧的URL 目录勾选框-->开启URL目录输入框-->将打算好的URL目录填好到输入框中

接下去往循环系统中拖进一个开启网页的流程-->选定开启网页流程-->启用上应用现今循环系统里的URL做为导航地址-->点一下存储。系统软件会在页面正下方的笔记本浏览器中开启循环系统中选取的URL相匹配的网页

。

到这儿,循环系统开启网页的步骤就配备完成了,运作步骤的情况下,系统软件会逐一的开启循环系统中设定的URL。最终你们不用配备一个采集数据信息的流程,这里就没有多讲,大伙儿才能 参照从菜鸟入门到熟练系列产品1:采集单独网页 本文。下面的图便是最后和步骤

下边是步骤最后的运作結果

版本更新V7.6.0(宣布) 2019-01-04

关键体验改善

【自定形式】增加JSON采集功能

【自定形式】增加滑动验证码鉴定

【自定形式】 提升高效率,目录鉴定速度翻倍

【自定形式】自动检索网页Ajax点一下,全手动配备Ajax恳求超时時间,配备每日任务更便捷

【自定形式】改善优化算法,挑选网页原素更精确

【当地采集】采集速率总体提升10~30%,采集高效率大幅度提升

【任务列表】重新建立任务列表页面,大幅度提升特点主要表现,很多任务管理器已不卡屏

【任务列表】任务列表添加手动更新体制,可随时随地查询每日任务全新情况

Bug修复

修补云采集查询数据信息迟滞困局

修补采集错误报告 排版设计衰弱困局

修补「开启网页时侯出現错码」难题

修补拖放步骤后突然消散的困局

修补定时执行导下来、全手动进库专用工具自弹出出困局

修补备份時间种类数据信息错误困局 查看全部

能采集,一切你仍然在网页可以看见的数据信息都还能采集,优采云采集器内嵌的标准销售市场中也有好多该类标准可免费下载,不用配备,运作标准就可以获取到这些数据信息。

怎么判别优采云采集器能采集什么信息呢?

简易而言,你可以在网页上看到的信息,优采云采集器均能进行采集,实际采集标准想要你自主设定或从标准销售市场内免费下载。

配备采集步骤时,有时左键点一下一个联接,弹下来选择项的情况下网页会跳转,怎样避免网页跳转?

某些应用脚本制做操纵手动跳转的网页将会会在点一下左键的情况下手动跳转, 给配备导致不变, 解决方案是应用右键单击, 以上键单击网页都是弹下来选择项,沒有一切差距。鼠标右键点一下通常还能 防止跳转的困局。

优采云采集器安裝取得成功后未能启动该如何办?

假如初次安裝取得成功后起动提醒“Windows早已配备优采云采集器,请稍后”,而且之后出現提醒“安裝时带来出错”,而且您的笔记本有360安全护卫等相仿笔记本软件早已运作,则将会是因为360等笔记本杀毒软件不正确的删掉了优采云运作所须要的文档,请撤离360等笔记本杀毒软件,重装优采云采集器就可以。 操作方法

先你们在建一个每日任务-->进到步骤设计方案网页页面-->加上一个循环系统流程到步骤中-->选定循环系统流程-->启用上笔记本软件两侧的URL 目录勾选框-->开启URL目录输入框-->将打算好的URL目录填好到输入框中

接下去往循环系统中拖进一个开启网页的流程-->选定开启网页流程-->启用上应用现今循环系统里的URL做为导航地址-->点一下存储。系统软件会在页面正下方的笔记本浏览器中开启循环系统中选取的URL相匹配的网页

。

到这儿,循环系统开启网页的步骤就配备完成了,运作步骤的情况下,系统软件会逐一的开启循环系统中设定的URL。最终你们不用配备一个采集数据信息的流程,这里就没有多讲,大伙儿才能 参照从菜鸟入门到熟练系列产品1:采集单独网页 本文。下面的图便是最后和步骤

下边是步骤最后的运作結果

版本更新V7.6.0(宣布) 2019-01-04

关键体验改善

【自定形式】增加JSON采集功能

【自定形式】增加滑动验证码鉴定

【自定形式】 提升高效率,目录鉴定速度翻倍

【自定形式】自动检索网页Ajax点一下,全手动配备Ajax恳求超时時间,配备每日任务更便捷

【自定形式】改善优化算法,挑选网页原素更精确

【当地采集】采集速率总体提升10~30%,采集高效率大幅度提升

【任务列表】重新建立任务列表页面,大幅度提升特点主要表现,很多任务管理器已不卡屏

【任务列表】任务列表添加手动更新体制,可随时随地查询每日任务全新情况

Bug修复

修补云采集查询数据信息迟滞困局

修补采集错误报告 排版设计衰弱困局

修补「开启网页时侯出現错码」难题

修补拖放步骤后突然消散的困局

修补定时执行导下来、全手动进库专用工具自弹出出困局

修补备份時间种类数据信息错误困局

优采云采集器(信息采集工具) v7.2.2.12221官方版

采集交流 • 优采云 发表了文章 • 0 个评论 • 376 次浏览 • 2020-08-09 21:20

6. 监控各大地产相关网站,采集新房二手房最新行情;

7. 采集各大车辆网站具体的新车二手车信息;

8. 发现和搜集潜在顾客信息;