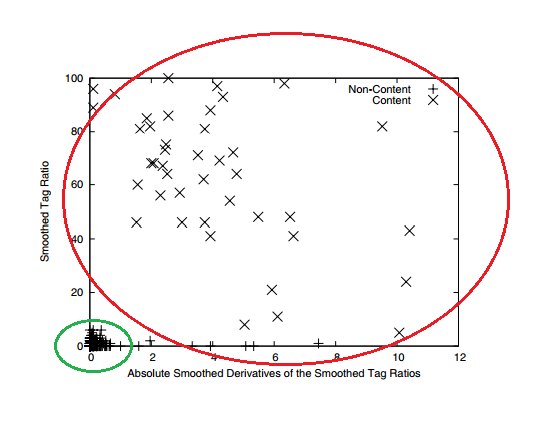

网页采集器的自动识别算法

免费的:优采云采集器 V2.5 免费安装版

采集交流 • 优采云 发表了文章 • 0 个评论 • 382 次浏览 • 2020-09-03 16:50

优采云 采集器是一个非常有用的网页信息采集工具。该工具界面简洁,操作简单,功能强大。有了它,我们可以采集转到我们需要的网页所有信息,零阈值,新手用户可以使用。

软件功能

1、零阈值:如果您不了解网络抓取工具技术,则将获得采集 网站数据。

2、多引擎,高速且稳定:内置高速浏览器引擎,还可以切换到HTTP引擎模式运行,采集数据更加高效。它还具有内置的JSON引擎,无需分析JSON数据结构,直观地选择JSON内容。

3、适用于各种网站:采集 99%的Internet 网站,包括单页应用程序Ajax加载和其他动态类型网站。

软件功能

1、该软件易于操作,您可以通过单击鼠标轻松选择要获取的内容;

2、支持三种高速引擎:浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器,再加上原创的内存优化,浏览器采集也可以高速甚至快速运行转换为HTTP模式操作并享受更高的采集速度!捕获JSON数据时,还可以使用浏览器可视化方法来选择需要用鼠标捕获的内容。无需分析JSON数据结构,因此非网页专业设计人员可以轻松获取所需数据;

3、无需分析网页请求和源代码,但支持更多网页采集;

4、先进的智能算法,可以一键生成目标元素XPATH,自动识别页面列表,自动识别分页中的下一页按钮……

5、支持丰富的数据导出方法,可以将其导出到txt文件,html文件,csv文件,excel文件或现有数据库,例如sqlite数据库,access数据库,sqlserver数据库,mysql数据库,您可以只需通过向导映射字段即可轻松导出到目标网站数据库。

软件优势

可视化向导:所有采集元素将自动生成采集数据。

1、计划任务:灵活定义运行时间,全自动运行。

2、多引擎支持:支持多个采集引擎,内置的高速浏览器内核,HTTP引擎和JSON引擎。

3、智能识别:它可以自动识别网页列表,采集字段和分页等。

4、拦截请求:自定义拦截域名,以方便过滤异地广告并提高采集的速度。

5、各种数据导出:可以将其导出到Txt,Excel,MySQL,SQLServer,SQlite,Access,网站等。 查看全部

优采云 采集器 V 2. 5免费安装版本

优采云 采集器是一个非常有用的网页信息采集工具。该工具界面简洁,操作简单,功能强大。有了它,我们可以采集转到我们需要的网页所有信息,零阈值,新手用户可以使用。

软件功能

1、零阈值:如果您不了解网络抓取工具技术,则将获得采集 网站数据。

2、多引擎,高速且稳定:内置高速浏览器引擎,还可以切换到HTTP引擎模式运行,采集数据更加高效。它还具有内置的JSON引擎,无需分析JSON数据结构,直观地选择JSON内容。

3、适用于各种网站:采集 99%的Internet 网站,包括单页应用程序Ajax加载和其他动态类型网站。

软件功能

1、该软件易于操作,您可以通过单击鼠标轻松选择要获取的内容;

2、支持三种高速引擎:浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器,再加上原创的内存优化,浏览器采集也可以高速甚至快速运行转换为HTTP模式操作并享受更高的采集速度!捕获JSON数据时,还可以使用浏览器可视化方法来选择需要用鼠标捕获的内容。无需分析JSON数据结构,因此非网页专业设计人员可以轻松获取所需数据;

3、无需分析网页请求和源代码,但支持更多网页采集;

4、先进的智能算法,可以一键生成目标元素XPATH,自动识别页面列表,自动识别分页中的下一页按钮……

5、支持丰富的数据导出方法,可以将其导出到txt文件,html文件,csv文件,excel文件或现有数据库,例如sqlite数据库,access数据库,sqlserver数据库,mysql数据库,您可以只需通过向导映射字段即可轻松导出到目标网站数据库。

软件优势

可视化向导:所有采集元素将自动生成采集数据。

1、计划任务:灵活定义运行时间,全自动运行。

2、多引擎支持:支持多个采集引擎,内置的高速浏览器内核,HTTP引擎和JSON引擎。

3、智能识别:它可以自动识别网页列表,采集字段和分页等。

4、拦截请求:自定义拦截域名,以方便过滤异地广告并提高采集的速度。

5、各种数据导出:可以将其导出到Txt,Excel,MySQL,SQLServer,SQlite,Access,网站等。

解决方案:利用专业数据采集工具获取网络数据的方法

采集交流 • 优采云 发表了文章 • 0 个评论 • 395 次浏览 • 2020-09-03 16:19

杨健

随着移动互联网的日益普及和广泛应用,互联网上的信息已成为人们获取信息的重要来源。人们通常使用诸如百度之类的搜索引擎来输入关键字并根据需要检索所需的Web内容。人们在浏览Internet信息时,也希望保存这些信息,选择适当的数据分析方法,并得出有效的结论,以便为将来的相关决策提供可靠的依据。

那么如何在页面上保存信息?通常情况下,您将在网页上选择所需的信息,然后通过“复制”和“粘贴”操作将其保存在计算机的本地文件中。尽管此方法简单直观,但操作复杂且不适用于海量数据信息采集。为了准确,方便地从Web上获取大量数据,人们设计并开发了各种用于采集数据信息的专业工具。借助专业工具中Web爬虫的强大功能,可以更准确,便捷和快速地获取网页信息。有许多此类专业数据采集工具。本文以“ 优采云”数据采集工具为例,介绍专业数据采集工具的功能,原理和用法。

“ 优采云”数据采集工具的功能

“ 优采云”数据采集工具是通用数据采集器,可以采集网页上98%的文本信息。它可以根据不同的网站提供多种网页采集策略,还可以自定义配置,以选择本地采集或云采集中网站中单个网页或多个网页的内容信息]方式自动提取并将获得的结果保存在Excel,CSV,HTML,数据库格式文件中,以方便后续数据处理和分析。

“ 优采云”数据采集工具的原理

在通常情况下,人们浏览网页时,必须先输入网站的网址;然后使用鼠标单击网页上的按钮或热点以找到他们想要获取的相关信息;最后选择信息并提取出来。以特定格式保存到文件。 “ 优采云”数据采集工具的核心原理是通过内置的Firefox内核浏览器模拟上述人类浏览网页的行为,并自动提取网页信息。这些功能由“ 优采云” 采集器的三个程序完成:负责任务配置和管理的主程序;任务的云采集控制和云集成数据管理程序;数据导出程序。

“ 优采云”数据采集工具的操作

在使用“ 优采云” 采集器之前,我们必须输入其官方网站 https://:///,下载并安装“ 优采云” 采集器客户端(本文使用“ 优采云以“ 8.版本0软件为例)。打开客户端软件,注册并登录使用。

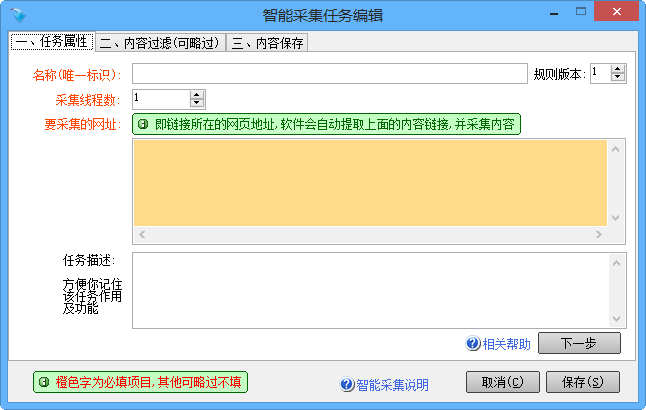

1.使用模板采集数据

在“ 优采云”客户端中内置了网站的许多采集模板。我们可以根据需要使用这些模板。如图1所示,按照提示快速轻松地获取网站信息。操作过程分为三个步骤:第一,选择目标模板网站;第二,选择目标模板。其次,配置数据采集参数(采集关键字,采集页面等),选择采集模式(本地采集或cloud 采集)自动提取数据;第三,选择输出文件格式并导出数据。

图1客户端内置的网站 采集模板

完成上述操作后,“ 优采云”客户端将以任务的形式保存整个操作过程和提取的数据。通过客户端的“我的任务”项,您可以随时查看提取的数据,还可以重复或修改当前任务。

2.自定义采集数据

当我们要根据自己的需求在网页上获取个性化数据时,我们需要使用自定义数据采集模式。首先确定目标网站和采集要求;然后打开网页,配置采集选项,并提取数据;最后,将数据导出到指定格式的文件中。

无论在“ 优采云”客户端中使用哪种模式采集网页数据信息,整个过程可以统一为三个步骤:配置任务,采集数据和导出数据。其中,配置采集选项参数是准确获取网页数据的关键。

“ 优采云”数据采集工具的应用案例

“ 优采云”数据采集工具可以采集上网站上的大部分网页信息,而不仅仅是某些专业网站数据的采集。以豆瓣电影排行榜前250名(https:// top 25 0))的数据为例,我们将介绍“ 优采云”数据采集工具的具体用法。

Douban 网站基于全面的数据,例如看过每部电影的人数和电影的评估,并通过算法分析生成了《豆瓣电影》前250名名单。前250个豆瓣电影的数据连续显示10个网页。每个网页显示25部电影。每部电影均包括电影排名,电影海报,中英文电影标题,电影导演和主演,参与者人数,豆瓣分数等。相关信息。我们可以根据实际需要,使用“ 优采云”数据采集工具获取豆瓣电影前250名的详细数据。具体方法如下。

1.获取有关列表中电影的信息

首先,在“豆瓣电影”网页上查看有关某部电影的信息,例如“霸王别姬”,并确定要获取的信息内容:电影排名,电影标题,导演,主要演员和剧情简介。其次,在“ 优采云”客户端的主页中,输入电影网页的网址,然后单击“开始采集”按钮以打开该网页;在显示网页的窗口中,单击“ NO2豆瓣电影Top 250”标签;在弹出的“操作技巧”窗口中,选择“ 采集此元素文本”,然后在“配置采集字段”窗口中显示“ NO2豆瓣电影排行榜250”选项。重复上述操作,然后选择其他选项卡,例如“告别我的后裔(199 3)”,“导演:陈凯歌”)和网页上的其他选项卡,以完成采集字段的配置,并修改字段名称。再次,在“操作技巧”窗口中执行“保存并启动采集”命令,并在“运行任务”窗口中启动“本地采集”选项以采集数据信息。最后,从[ k1]转换为特定格式的文件。

完成数据信息采集后,除了通过打开数据文件查看采集的信息外,还可以从主页上的“我的任务”项目查看采集的好数据。 “ 优采云”客户端。

2.获取网页的所有电影信息

豆瓣电影列表的每个页面将显示有关25部电影的信息,并且每部电影都显示相同的信息项,例如电影排名,海报,电影中文名称,导演和男主角。然后,“ 优采云”客户端提取每个电影的数据的操作是相同的。因此,我们只需要完成一部电影的数据采集配置,并对其余电影重复该操作。

首先,我们必须确定要求,在“ 优采云”客户端的主页上输入要获取的信息的URL,然后打开该网页。其次,单击鼠标以选择与电影相关的数据区域。在弹出的“操作提示”窗口中,选择“选择子元素”选项,选择电影排名,海报,电影中文名称,导演和主演字段;然后单击鼠标选择“全选”以创建一个循环列表,在网页中选择25部电影的相关数据项;然后在预览窗口中单击“ 采集数据”选项,查看并修改数据字段名称为采集。最后,启动“本地采集”以获取数据信息并生成数据文件。

3.获取列表中的所有电影信息

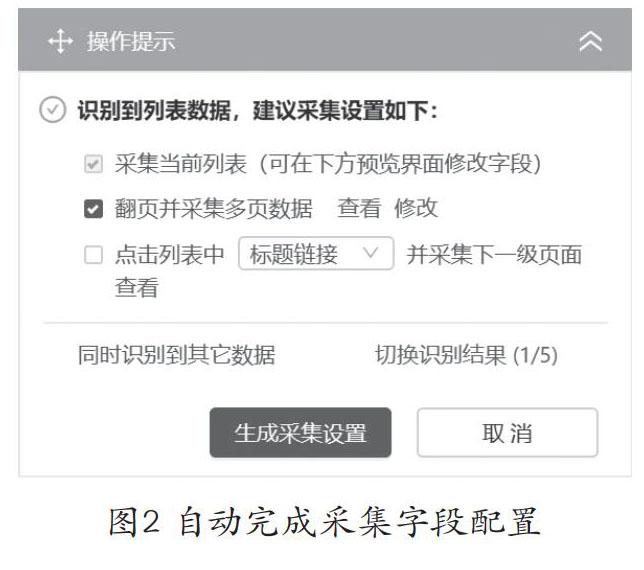

除了上面提到的手动数据选择采集字段外,由于豆瓣电影排名前250名列表中每部电影的显示信息相同,因此我们可以使用“操作提示”窗口获取所有数据250个电影在提示信息中,自动配置要提取的数据项以完成电影信息的获取。

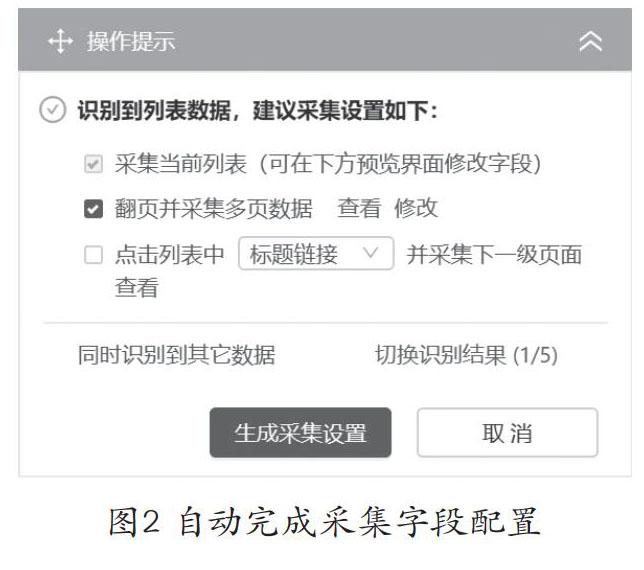

首先,弄清信息要求,确定URL https://movie.douban.com/top 250,在“ 优采云”客户端上打开网页;在“操作提示”窗口中选择“自动识别网页”。确定“ 优采云”算法后,采集字段配置自动完成,如图2所示。在“数据预览”窗口中,您可以看到即将到来的采集的字段和数据,以及您可以通过“修改”和“删除”操作来调整与字段相关的信息。然后选择“生成采集设置”,保存并启动采集数据。提取数据后,将其保存为特定格式的文件。

图2自动完成采集字段配置

除上述应用程序外,“ 优采云” data 采集工具还可以为许多采集需求和具有不同结构的网页执行data 采集,例如获取特定数量的网页,使用云采集等。这些是每个人都可以进一步研究和研究的内容。

专业数据采集工具和Web爬网程序技术已逐渐成为获取网络信息的重要手段,但在现实世界中,并非所有数据都可以任意提取和使用。数据采集时,必须遵守相关法律法规,并负责任地,合理地使用网络技术和网络信息。

资助项目:北京市教育科学“十三五” 2018年总项目“高中信息技术教学中计算思维训练案例研究”,项目编号:CDDB18183。作者是北京教育学院“北京中小学人工智能教学实践研究”特聘教师工作室成员。

参考

[1]朱志婷,范磊。普通高中教科书和信息技术必修课[M]。北京:人民教育出版社,中国地图出版社,201 9.

“中小学信息技术教育” 2020年第6期

中小学的其他信息技术教育文章

停课,不间断教学,不间断学校,教育信息技术显示出“内在力量”

亿万中小学生在网上享受高质量的教育,没有“停课”。

教育部发布了《中小学幼儿园教师在线培训实施指南》

北京:2020年将建立教育大数据平台

资本教育距离帮助和田教师提高他们的教育和教学能力

教育部发布了六个超过标准和高级培训的义务教育科目否定名单 查看全部

使用专业数据采集工具获取网络数据的方法

杨健

随着移动互联网的日益普及和广泛应用,互联网上的信息已成为人们获取信息的重要来源。人们通常使用诸如百度之类的搜索引擎来输入关键字并根据需要检索所需的Web内容。人们在浏览Internet信息时,也希望保存这些信息,选择适当的数据分析方法,并得出有效的结论,以便为将来的相关决策提供可靠的依据。

那么如何在页面上保存信息?通常情况下,您将在网页上选择所需的信息,然后通过“复制”和“粘贴”操作将其保存在计算机的本地文件中。尽管此方法简单直观,但操作复杂且不适用于海量数据信息采集。为了准确,方便地从Web上获取大量数据,人们设计并开发了各种用于采集数据信息的专业工具。借助专业工具中Web爬虫的强大功能,可以更准确,便捷和快速地获取网页信息。有许多此类专业数据采集工具。本文以“ 优采云”数据采集工具为例,介绍专业数据采集工具的功能,原理和用法。

“ 优采云”数据采集工具的功能

“ 优采云”数据采集工具是通用数据采集器,可以采集网页上98%的文本信息。它可以根据不同的网站提供多种网页采集策略,还可以自定义配置,以选择本地采集或云采集中网站中单个网页或多个网页的内容信息]方式自动提取并将获得的结果保存在Excel,CSV,HTML,数据库格式文件中,以方便后续数据处理和分析。

“ 优采云”数据采集工具的原理

在通常情况下,人们浏览网页时,必须先输入网站的网址;然后使用鼠标单击网页上的按钮或热点以找到他们想要获取的相关信息;最后选择信息并提取出来。以特定格式保存到文件。 “ 优采云”数据采集工具的核心原理是通过内置的Firefox内核浏览器模拟上述人类浏览网页的行为,并自动提取网页信息。这些功能由“ 优采云” 采集器的三个程序完成:负责任务配置和管理的主程序;任务的云采集控制和云集成数据管理程序;数据导出程序。

“ 优采云”数据采集工具的操作

在使用“ 优采云” 采集器之前,我们必须输入其官方网站 https://:///,下载并安装“ 优采云” 采集器客户端(本文使用“ 优采云以“ 8.版本0软件为例)。打开客户端软件,注册并登录使用。

1.使用模板采集数据

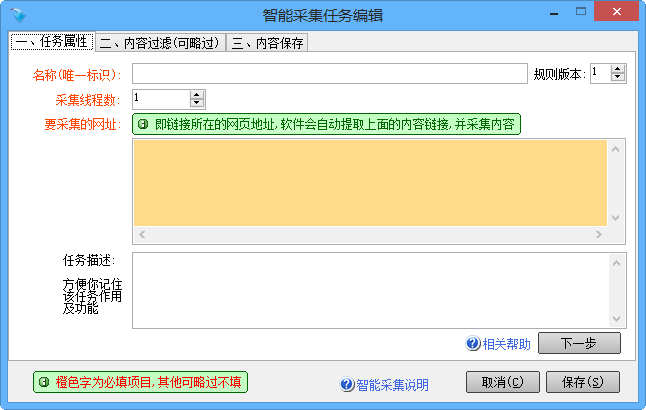

在“ 优采云”客户端中内置了网站的许多采集模板。我们可以根据需要使用这些模板。如图1所示,按照提示快速轻松地获取网站信息。操作过程分为三个步骤:第一,选择目标模板网站;第二,选择目标模板。其次,配置数据采集参数(采集关键字,采集页面等),选择采集模式(本地采集或cloud 采集)自动提取数据;第三,选择输出文件格式并导出数据。

图1客户端内置的网站 采集模板

完成上述操作后,“ 优采云”客户端将以任务的形式保存整个操作过程和提取的数据。通过客户端的“我的任务”项,您可以随时查看提取的数据,还可以重复或修改当前任务。

2.自定义采集数据

当我们要根据自己的需求在网页上获取个性化数据时,我们需要使用自定义数据采集模式。首先确定目标网站和采集要求;然后打开网页,配置采集选项,并提取数据;最后,将数据导出到指定格式的文件中。

无论在“ 优采云”客户端中使用哪种模式采集网页数据信息,整个过程可以统一为三个步骤:配置任务,采集数据和导出数据。其中,配置采集选项参数是准确获取网页数据的关键。

“ 优采云”数据采集工具的应用案例

“ 优采云”数据采集工具可以采集上网站上的大部分网页信息,而不仅仅是某些专业网站数据的采集。以豆瓣电影排行榜前250名(https:// top 25 0))的数据为例,我们将介绍“ 优采云”数据采集工具的具体用法。

Douban 网站基于全面的数据,例如看过每部电影的人数和电影的评估,并通过算法分析生成了《豆瓣电影》前250名名单。前250个豆瓣电影的数据连续显示10个网页。每个网页显示25部电影。每部电影均包括电影排名,电影海报,中英文电影标题,电影导演和主演,参与者人数,豆瓣分数等。相关信息。我们可以根据实际需要,使用“ 优采云”数据采集工具获取豆瓣电影前250名的详细数据。具体方法如下。

1.获取有关列表中电影的信息

首先,在“豆瓣电影”网页上查看有关某部电影的信息,例如“霸王别姬”,并确定要获取的信息内容:电影排名,电影标题,导演,主要演员和剧情简介。其次,在“ 优采云”客户端的主页中,输入电影网页的网址,然后单击“开始采集”按钮以打开该网页;在显示网页的窗口中,单击“ NO2豆瓣电影Top 250”标签;在弹出的“操作技巧”窗口中,选择“ 采集此元素文本”,然后在“配置采集字段”窗口中显示“ NO2豆瓣电影排行榜250”选项。重复上述操作,然后选择其他选项卡,例如“告别我的后裔(199 3)”,“导演:陈凯歌”)和网页上的其他选项卡,以完成采集字段的配置,并修改字段名称。再次,在“操作技巧”窗口中执行“保存并启动采集”命令,并在“运行任务”窗口中启动“本地采集”选项以采集数据信息。最后,从[ k1]转换为特定格式的文件。

完成数据信息采集后,除了通过打开数据文件查看采集的信息外,还可以从主页上的“我的任务”项目查看采集的好数据。 “ 优采云”客户端。

2.获取网页的所有电影信息

豆瓣电影列表的每个页面将显示有关25部电影的信息,并且每部电影都显示相同的信息项,例如电影排名,海报,电影中文名称,导演和男主角。然后,“ 优采云”客户端提取每个电影的数据的操作是相同的。因此,我们只需要完成一部电影的数据采集配置,并对其余电影重复该操作。

首先,我们必须确定要求,在“ 优采云”客户端的主页上输入要获取的信息的URL,然后打开该网页。其次,单击鼠标以选择与电影相关的数据区域。在弹出的“操作提示”窗口中,选择“选择子元素”选项,选择电影排名,海报,电影中文名称,导演和主演字段;然后单击鼠标选择“全选”以创建一个循环列表,在网页中选择25部电影的相关数据项;然后在预览窗口中单击“ 采集数据”选项,查看并修改数据字段名称为采集。最后,启动“本地采集”以获取数据信息并生成数据文件。

3.获取列表中的所有电影信息

除了上面提到的手动数据选择采集字段外,由于豆瓣电影排名前250名列表中每部电影的显示信息相同,因此我们可以使用“操作提示”窗口获取所有数据250个电影在提示信息中,自动配置要提取的数据项以完成电影信息的获取。

首先,弄清信息要求,确定URL https://movie.douban.com/top 250,在“ 优采云”客户端上打开网页;在“操作提示”窗口中选择“自动识别网页”。确定“ 优采云”算法后,采集字段配置自动完成,如图2所示。在“数据预览”窗口中,您可以看到即将到来的采集的字段和数据,以及您可以通过“修改”和“删除”操作来调整与字段相关的信息。然后选择“生成采集设置”,保存并启动采集数据。提取数据后,将其保存为特定格式的文件。

图2自动完成采集字段配置

除上述应用程序外,“ 优采云” data 采集工具还可以为许多采集需求和具有不同结构的网页执行data 采集,例如获取特定数量的网页,使用云采集等。这些是每个人都可以进一步研究和研究的内容。

专业数据采集工具和Web爬网程序技术已逐渐成为获取网络信息的重要手段,但在现实世界中,并非所有数据都可以任意提取和使用。数据采集时,必须遵守相关法律法规,并负责任地,合理地使用网络技术和网络信息。

资助项目:北京市教育科学“十三五” 2018年总项目“高中信息技术教学中计算思维训练案例研究”,项目编号:CDDB18183。作者是北京教育学院“北京中小学人工智能教学实践研究”特聘教师工作室成员。

参考

[1]朱志婷,范磊。普通高中教科书和信息技术必修课[M]。北京:人民教育出版社,中国地图出版社,201 9.

“中小学信息技术教育” 2020年第6期

中小学的其他信息技术教育文章

停课,不间断教学,不间断学校,教育信息技术显示出“内在力量”

亿万中小学生在网上享受高质量的教育,没有“停课”。

教育部发布了《中小学幼儿园教师在线培训实施指南》

北京:2020年将建立教育大数据平台

资本教育距离帮助和田教师提高他们的教育和教学能力

教育部发布了六个超过标准和高级培训的义务教育科目否定名单

解读:百度识别原创文章算法的具体细节

采集交流 • 优采云 发表了文章 • 0 个评论 • 166 次浏览 • 2020-09-03 13:11

根据百度工程师的说法,在百度大数据云计算平台上开发的百度原创识别系统可以快速实现所有中文互联网网页的重复聚合和链接点关系分析. 首先,通过内容相似度聚合采集和原创,并将相似的网页聚合为原创标识的候选集;其次,对于原创个候选集,使用作者,发布时间,链接点,用户数百种因素(例如评论,作者和站点历史原创情况,转发轨迹等)来识别和判断原创网页最后,由价值分析系统判断原创内容的价值,以适当地指导最终排名. 同时,LEE表示,通过实验和真实的在线数据,百度原创在识别“起源”算法方面取得了一些进展,并解决了新闻,信息和其他领域中的大多数问题. 下面简要介绍原创 文章算法的具体细节.

1. 搜索引擎为什么要注意原创

1.1 采集洪水

百度的一项调查显示,从传统媒体报纸到娱乐网站花边新闻,从游戏指南到产品评论,甚至是提醒,超过80%的新闻和信息都是手动或通过机器采集重新发布的由大学图书馆发送的邮件中有正在运行机器的站点采集. 可以说,高质量的原创含量是被采集包围的广阔海洋中的小米. 对于搜索引擎来说,在海中搜索小米是一项艰巨而艰巨的任务.

1.2改善搜索用户体验

数字化降低了传播成本,工具化降低了采集的成本,并降低了机器采集的行为,从而混淆了内容来源并降低了内容质量. 在采集的过程中,无意或有意地在采集网页上出现了诸如网站内容不完整或不完整,格式混乱或垃圾邮件等问题,这严重影响了搜索结果的质量和用户体验. 搜索引擎重视原创的根本原因是为了改善用户体验. 这里提到的原创是高质量的原创内容.

1.3鼓励原创位作者和文章

以采集重印,可转移高质量原创网站的访问量,并且不再使用原创作者的名字,这将直接影响高质量原创的收入网站管理员和作者. 从长远来看,它将影响原创人的热情,不利于创新,也不利于生产新的高质量内容. 鼓励高质量原创,鼓励创新以及为原创网站和作者提供合理的访问量,从而促进Internet内容的繁荣,应该是搜索引擎的一项重要任务.

第二,采集非常狡猾,很难识别原创

2.1 采集伪装为原创,篡改了关键信息

当前,在采集 原创内容的大量网站批处理之后,使用手册或机器方法来伪造诸如作者,发布时间和来源之类的关键信息,并假装为原创 . 这种假冒原创需要由搜索引擎识别并进行相应调整.

2.2内容生成器,制造伪原创

使用诸如自动文章生成器之类的工具“创建”文章文章,然后安装醒目的标题,现在的成本非常低,而且必须是原创的. 但是,原创具有社会共识价值,而不是制造不合理的垃圾,这些垃圾可以被视为有价值和高质量的原创内容. 尽管内容是唯一的,但它没有社会共识的价值. 搜索引擎需要识别并打击这种伪原创类型.

2.3区分网页,难以提取结构化信息

不同的站点具有相对较大的结构差异,并且html标签的含义和分布也不同. 因此,提取诸如标题,作者和时间之类的关键信息的难度也相对较大. 当前的中国互联网规模要全面,准确,及时是不容易的. 这部分将需要搜索引擎和网站管理员的配合才能更平稳地运行. 如果网站站长将更清晰的结构告知搜索引擎网页布局,将使搜索引擎能够有效地提取原创个相关信息.

原创是一个环境问题,需要每个人维护. 网站管理员应做更多的工作原创,并推荐更多的工作原创. 百度将继续努力改进排序算法,鼓励原创内容,并成为原创,原创网站的作者. 查看全部

百度识别原创 文章算法的细节

根据百度工程师的说法,在百度大数据云计算平台上开发的百度原创识别系统可以快速实现所有中文互联网网页的重复聚合和链接点关系分析. 首先,通过内容相似度聚合采集和原创,并将相似的网页聚合为原创标识的候选集;其次,对于原创个候选集,使用作者,发布时间,链接点,用户数百种因素(例如评论,作者和站点历史原创情况,转发轨迹等)来识别和判断原创网页最后,由价值分析系统判断原创内容的价值,以适当地指导最终排名. 同时,LEE表示,通过实验和真实的在线数据,百度原创在识别“起源”算法方面取得了一些进展,并解决了新闻,信息和其他领域中的大多数问题. 下面简要介绍原创 文章算法的具体细节.

1. 搜索引擎为什么要注意原创

1.1 采集洪水

百度的一项调查显示,从传统媒体报纸到娱乐网站花边新闻,从游戏指南到产品评论,甚至是提醒,超过80%的新闻和信息都是手动或通过机器采集重新发布的由大学图书馆发送的邮件中有正在运行机器的站点采集. 可以说,高质量的原创含量是被采集包围的广阔海洋中的小米. 对于搜索引擎来说,在海中搜索小米是一项艰巨而艰巨的任务.

1.2改善搜索用户体验

数字化降低了传播成本,工具化降低了采集的成本,并降低了机器采集的行为,从而混淆了内容来源并降低了内容质量. 在采集的过程中,无意或有意地在采集网页上出现了诸如网站内容不完整或不完整,格式混乱或垃圾邮件等问题,这严重影响了搜索结果的质量和用户体验. 搜索引擎重视原创的根本原因是为了改善用户体验. 这里提到的原创是高质量的原创内容.

1.3鼓励原创位作者和文章

以采集重印,可转移高质量原创网站的访问量,并且不再使用原创作者的名字,这将直接影响高质量原创的收入网站管理员和作者. 从长远来看,它将影响原创人的热情,不利于创新,也不利于生产新的高质量内容. 鼓励高质量原创,鼓励创新以及为原创网站和作者提供合理的访问量,从而促进Internet内容的繁荣,应该是搜索引擎的一项重要任务.

第二,采集非常狡猾,很难识别原创

2.1 采集伪装为原创,篡改了关键信息

当前,在采集 原创内容的大量网站批处理之后,使用手册或机器方法来伪造诸如作者,发布时间和来源之类的关键信息,并假装为原创 . 这种假冒原创需要由搜索引擎识别并进行相应调整.

2.2内容生成器,制造伪原创

使用诸如自动文章生成器之类的工具“创建”文章文章,然后安装醒目的标题,现在的成本非常低,而且必须是原创的. 但是,原创具有社会共识价值,而不是制造不合理的垃圾,这些垃圾可以被视为有价值和高质量的原创内容. 尽管内容是唯一的,但它没有社会共识的价值. 搜索引擎需要识别并打击这种伪原创类型.

2.3区分网页,难以提取结构化信息

不同的站点具有相对较大的结构差异,并且html标签的含义和分布也不同. 因此,提取诸如标题,作者和时间之类的关键信息的难度也相对较大. 当前的中国互联网规模要全面,准确,及时是不容易的. 这部分将需要搜索引擎和网站管理员的配合才能更平稳地运行. 如果网站站长将更清晰的结构告知搜索引擎网页布局,将使搜索引擎能够有效地提取原创个相关信息.

原创是一个环境问题,需要每个人维护. 网站管理员应做更多的工作原创,并推荐更多的工作原创. 百度将继续努力改进排序算法,鼓励原创内容,并成为原创,原创网站的作者.

最新版本:软件下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 196 次浏览 • 2020-09-03 12:31

优采云 采集器是一个非常有用的网页信息采集工具. 该工具界面简洁,操作简单,功能强大. 有了它,我们可以采集转到我们需要的网页所有信息,零阈值,新手用户可以使用.

[软件功能]

零阈值: 如果您不了解网络抓取工具技术,则将获得采集 网站个数据

多引擎,高速且稳定: 内置的高速浏览器引擎,还可以切换到HTTP引擎模式运行,采集数据更加高效. 它还具有内置的JSON引擎,无需分析JSON数据结构,直观地选择JSON内容.

适用于各种网站: 采集 99%的Internet 网站,包括单页应用程序Ajax加载和其他动态类型网站.

[软件功能]

该软件易于操作,并且可以通过单击鼠标轻松选择要捕获的内容;

支持三种高速引擎: 浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器以及原创内存优化,因此浏览器采集也可以高速运行,甚至可以快速运行转换为HTTP方式运行,享受更高的采集速度!捕获JSON数据时,还可以使用浏览器可视化方法来选择要用鼠标捕获的内容. 无需分析JSON数据结构,因此非网页专业设计人员可以轻松捕获所需数据;

无需分析网页请求和源代码,但支持更多网页采集;

高级智能算法可以一键生成目标元素XPATH,自动识别网页列表,自动识别分页中的下一页按钮...

支持丰富的数据导出方法,可以通过向导将其导出到txt文件,html文件,csv文件,excel文件或现有数据库,例如sqlite数据库,access数据库,sqlserver数据库,mysql数据库. 易于映射字段,并且可以轻松导出到目标网站数据库.

[软件优势]

可视化向导: 所有采集个元素,自动生成采集个数据

计划任务: 灵活定义运行时间,全自动运行

多引擎支持: 支持多个采集引擎,内置的高速浏览器内核,HTTP引擎和JSON引擎

智能识别: 它可以自动识别网页列表,采集字段和分页等.

拦截请求: 自定义拦截域名,以方便过滤异地广告并提高采集的速度

各种数据导出: 可以导出到Txt,Excel,MySQL,SQLServer,SQlite,Access,网站等. 查看全部

软件下载

优采云 采集器是一个非常有用的网页信息采集工具. 该工具界面简洁,操作简单,功能强大. 有了它,我们可以采集转到我们需要的网页所有信息,零阈值,新手用户可以使用.

[软件功能]

零阈值: 如果您不了解网络抓取工具技术,则将获得采集 网站个数据

多引擎,高速且稳定: 内置的高速浏览器引擎,还可以切换到HTTP引擎模式运行,采集数据更加高效. 它还具有内置的JSON引擎,无需分析JSON数据结构,直观地选择JSON内容.

适用于各种网站: 采集 99%的Internet 网站,包括单页应用程序Ajax加载和其他动态类型网站.

[软件功能]

该软件易于操作,并且可以通过单击鼠标轻松选择要捕获的内容;

支持三种高速引擎: 浏览器引擎,HTTP引擎,JSON引擎,内置优化的Firefox浏览器以及原创内存优化,因此浏览器采集也可以高速运行,甚至可以快速运行转换为HTTP方式运行,享受更高的采集速度!捕获JSON数据时,还可以使用浏览器可视化方法来选择要用鼠标捕获的内容. 无需分析JSON数据结构,因此非网页专业设计人员可以轻松捕获所需数据;

无需分析网页请求和源代码,但支持更多网页采集;

高级智能算法可以一键生成目标元素XPATH,自动识别网页列表,自动识别分页中的下一页按钮...

支持丰富的数据导出方法,可以通过向导将其导出到txt文件,html文件,csv文件,excel文件或现有数据库,例如sqlite数据库,access数据库,sqlserver数据库,mysql数据库. 易于映射字段,并且可以轻松导出到目标网站数据库.

[软件优势]

可视化向导: 所有采集个元素,自动生成采集个数据

计划任务: 灵活定义运行时间,全自动运行

多引擎支持: 支持多个采集引擎,内置的高速浏览器内核,HTTP引擎和JSON引擎

智能识别: 它可以自动识别网页列表,采集字段和分页等.

拦截请求: 自定义拦截域名,以方便过滤异地广告并提高采集的速度

各种数据导出: 可以导出到Txt,Excel,MySQL,SQLServer,SQlite,Access,网站等.

最近发布:K风asp.net网页搜索引擎系统

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2020-09-03 09:08

K-PageSearch是由Kwindsoft独立开发的专业Web搜索引擎系统. 它具有先进的智能分析和海量数据检索技术. 核心由多线程采集系统,智能分析系统,海量索引系统和全文搜索系统组成. 大部分组成. 该系统采用专业的搜索引擎系统架构,并支持海量数据的毫秒级全文检索. 专业的全文搜索产品主要为大中型行业搜索引擎,本地搜索引擎,专业信息搜索引擎和其他应用程序领域设计,为用户提供了海量数据全文搜索应用程序的理想解决方案.

K-wind网络搜索V2.2版本的主要改进: 改进了索引系统的读写性能,并将索引速度提高了约10倍;

SP5: 修复和改进搜索算法;

SP4: 修订和优化一些核心程序;

SP3: 优化检索过程,修复程序错误;

SP2的改进: 修复了由于搜索组件错误而导致的缓慢搜索速度,大大提高了搜索速度;

SP1的改进: 增加哈希值的长度,基本上可以达到100%采集,完全爬网整个网站网页,并增加搜索排名列表的功能;

K-wind Web搜索V2.1版本的主要改进: 使用.NET技术开发Web前端程序,使用UTF-8网页编码,新的索引系统,开放式管理工具源代码; SP1的改进: 修复了网页编码的自动识别,改进了Hash使蜘蛛爬网更加全面,在特殊情况下更正了存储错误等.

K-wind网络搜索功能的特征

多线程网络蜘蛛

网页定位采集

自动识别多语言网页编码

删除哈希表网页的重复

智能网页正文提取

基于同义词库的智能汉语分词

中文分词词库管理

海量数据的毫秒级全文检索

缓存技术

网页快照

高级搜索

出价排名

网络蜘蛛

网络蜘蛛使用多线程并发采集网页,并结合有效的采集机制和策略部署,以最大化网页采集的效率. 支持网页方向采集,这是垂直搜索引擎提高数据质量和相关性的一项关键技术. 用户可以自定义采集规则以定位特定的网页采集. 支持多种动态和静态网页类型采集,自动识别多语言网页编码. 哈希表网页重复数据删除技术具有高性能和低系统占用率的特点,使网络蜘蛛能够高效,稳定地运行. 支持单个或批量网站 采集,自动采集,自动更新功能.

文本提取

智能网页文本提取技术,其功能是提取网页的主题中心内容并过滤与网页主题无关的信息(广告,导航,版权和其他非网页内容信息) ). 该技术有效地提高了网页信息的质量采集和检索相关性,智能自动识别,准确的网页文本提取以及95%以上的准确率.

中文分词

基于同义词库的智能中文分词技术支持多种智能分析技术,例如中英文分词,简体中文和繁体字体转换,全角半角转换以及中文名称识别. 用户可以根据自己的应用需求扩展和维护词典,以达到最佳的分词效果.

全文搜索

采用海量数据索引系统架构和先进的全文检索算法技术,结合高效的检索优化策略,支持海量数据毫秒级检索速度和多用户并发检索. 高级搜索支持自定义检索方法,以满足用户的不同检索需求. 采用高效的缓存技术策略,以提高系统的稳定性和负载能力,减轻系统负担. 缓存的数据会根据特定条件自动更新.

适用对象

适用于在企业,政府机构,学校等的网站组或Internet 网站组中构建Web搜索引擎;

适用于各个行业和领域网站组以构建行业网络搜索引擎;

适合网站个小组在省,市,区和其他地方构建本地网络搜索引擎; 查看全部

K wind asp.net网络搜索引擎系统

K-PageSearch是由Kwindsoft独立开发的专业Web搜索引擎系统. 它具有先进的智能分析和海量数据检索技术. 核心由多线程采集系统,智能分析系统,海量索引系统和全文搜索系统组成. 大部分组成. 该系统采用专业的搜索引擎系统架构,并支持海量数据的毫秒级全文检索. 专业的全文搜索产品主要为大中型行业搜索引擎,本地搜索引擎,专业信息搜索引擎和其他应用程序领域设计,为用户提供了海量数据全文搜索应用程序的理想解决方案.

K-wind网络搜索V2.2版本的主要改进: 改进了索引系统的读写性能,并将索引速度提高了约10倍;

SP5: 修复和改进搜索算法;

SP4: 修订和优化一些核心程序;

SP3: 优化检索过程,修复程序错误;

SP2的改进: 修复了由于搜索组件错误而导致的缓慢搜索速度,大大提高了搜索速度;

SP1的改进: 增加哈希值的长度,基本上可以达到100%采集,完全爬网整个网站网页,并增加搜索排名列表的功能;

K-wind Web搜索V2.1版本的主要改进: 使用.NET技术开发Web前端程序,使用UTF-8网页编码,新的索引系统,开放式管理工具源代码; SP1的改进: 修复了网页编码的自动识别,改进了Hash使蜘蛛爬网更加全面,在特殊情况下更正了存储错误等.

K-wind网络搜索功能的特征

多线程网络蜘蛛

网页定位采集

自动识别多语言网页编码

删除哈希表网页的重复

智能网页正文提取

基于同义词库的智能汉语分词

中文分词词库管理

海量数据的毫秒级全文检索

缓存技术

网页快照

高级搜索

出价排名

网络蜘蛛

网络蜘蛛使用多线程并发采集网页,并结合有效的采集机制和策略部署,以最大化网页采集的效率. 支持网页方向采集,这是垂直搜索引擎提高数据质量和相关性的一项关键技术. 用户可以自定义采集规则以定位特定的网页采集. 支持多种动态和静态网页类型采集,自动识别多语言网页编码. 哈希表网页重复数据删除技术具有高性能和低系统占用率的特点,使网络蜘蛛能够高效,稳定地运行. 支持单个或批量网站 采集,自动采集,自动更新功能.

文本提取

智能网页文本提取技术,其功能是提取网页的主题中心内容并过滤与网页主题无关的信息(广告,导航,版权和其他非网页内容信息) ). 该技术有效地提高了网页信息的质量采集和检索相关性,智能自动识别,准确的网页文本提取以及95%以上的准确率.

中文分词

基于同义词库的智能中文分词技术支持多种智能分析技术,例如中英文分词,简体中文和繁体字体转换,全角半角转换以及中文名称识别. 用户可以根据自己的应用需求扩展和维护词典,以达到最佳的分词效果.

全文搜索

采用海量数据索引系统架构和先进的全文检索算法技术,结合高效的检索优化策略,支持海量数据毫秒级检索速度和多用户并发检索. 高级搜索支持自定义检索方法,以满足用户的不同检索需求. 采用高效的缓存技术策略,以提高系统的稳定性和负载能力,减轻系统负担. 缓存的数据会根据特定条件自动更新.

适用对象

适用于在企业,政府机构,学校等的网站组或Internet 网站组中构建Web搜索引擎;

适用于各个行业和领域网站组以构建行业网络搜索引擎;

适合网站个小组在省,市,区和其他地方构建本地网络搜索引擎;

行业解决方案:网络采集器-阿里云开发者社区

采集交流 • 优采云 发表了文章 • 0 个评论 • 279 次浏览 • 2020-09-01 01:36

报价: %B4%F3%CE%B0 / blog / item / 941ed8b49ee58f6b8bd4b2e2.html

浏览网络时,我们将在浏览器地址栏中输入需要访问的地址. 通常,这些地址以HTTP开头,表示使用HTTP协议与站点进行通信. 准确地说,HTTP是超文本传输. 归根结底,协议仍然是文本,因此传输的内容是文本,浏览的网页也是文本. 这是我们可以采集 网站使用的数据的基础.

同时,在地址栏中,我们还将在URL中看到单词www,这意味着我们正在请求Web服务. WWW服务(3W服务)是当前使用最广泛的基本Internet应用程序. WWW服务使用超文本链接(HTML),因此可以轻松地从一个信息页面转换为另一信息页面. 它不仅可以查看文本,还可以欣赏图片,音乐和动画.

到目前为止,我们知道浏览网页实际上是使用HTTP协议从Web服务请求超文本(HTML). 此超文本收录文本,图片,音乐和其他内容. 这是我们最终看到的网页. 同时,我们拥有的采集数据也收录在此超文本中. 超文本(HTML)有其自己的规则. 通过这些规则,浏览器将自动识别超文本格式并知道如何显示页面. 这是我们看到不同网页样式的基础. 如果我们通过浏览器查看网页的源代码,则会发现很多标记内容. 这是HTML的标准内容,当然还有许多其他规范.

手动处理数据采集:

1. 使用浏览器(IE或Firefox)打开网页

2. 使用浏览器查看网页的源代码(Firefox)或查看源文件(IE),以打开该网页的传输文本内容

3. 您可以将所有文本内容复制到专业文本编辑工具(例如UltraEdit)中,或直接使用浏览器自身的功能

4. 通过搜索功能开始找到想要的东西

5. 找到之后,您需要将其复制出来

参考资料

Network Miner Data 采集软件用户手册

C#多线程网页采集器(蜘蛛)

采集函数(采集,分析,替换,存储集成)

ASP.NET(C#)经典采集代码

下载数据采集的方法和示例

Wei Yan ASP.NET数据采集封装类,它封装了数据采集所需的所有方法

log4net的详细使用

ASP.N 优采云 采集器系统通用正则表达式

.NETC#大量发送带有附件中文发件人密件抄送电子邮件的HTML格式

.net程序中资源文件保护的讨论

C#使用代理爬网

sql生成具有指定位数的100W随机数的方法(仅用了不到1分钟的时间)(完成) 查看全部

网络采集器-阿里云开发者社区

报价: %B4%F3%CE%B0 / blog / item / 941ed8b49ee58f6b8bd4b2e2.html

浏览网络时,我们将在浏览器地址栏中输入需要访问的地址. 通常,这些地址以HTTP开头,表示使用HTTP协议与站点进行通信. 准确地说,HTTP是超文本传输. 归根结底,协议仍然是文本,因此传输的内容是文本,浏览的网页也是文本. 这是我们可以采集 网站使用的数据的基础.

同时,在地址栏中,我们还将在URL中看到单词www,这意味着我们正在请求Web服务. WWW服务(3W服务)是当前使用最广泛的基本Internet应用程序. WWW服务使用超文本链接(HTML),因此可以轻松地从一个信息页面转换为另一信息页面. 它不仅可以查看文本,还可以欣赏图片,音乐和动画.

到目前为止,我们知道浏览网页实际上是使用HTTP协议从Web服务请求超文本(HTML). 此超文本收录文本,图片,音乐和其他内容. 这是我们最终看到的网页. 同时,我们拥有的采集数据也收录在此超文本中. 超文本(HTML)有其自己的规则. 通过这些规则,浏览器将自动识别超文本格式并知道如何显示页面. 这是我们看到不同网页样式的基础. 如果我们通过浏览器查看网页的源代码,则会发现很多标记内容. 这是HTML的标准内容,当然还有许多其他规范.

手动处理数据采集:

1. 使用浏览器(IE或Firefox)打开网页

2. 使用浏览器查看网页的源代码(Firefox)或查看源文件(IE),以打开该网页的传输文本内容

3. 您可以将所有文本内容复制到专业文本编辑工具(例如UltraEdit)中,或直接使用浏览器自身的功能

4. 通过搜索功能开始找到想要的东西

5. 找到之后,您需要将其复制出来

参考资料

Network Miner Data 采集软件用户手册

C#多线程网页采集器(蜘蛛)

采集函数(采集,分析,替换,存储集成)

ASP.NET(C#)经典采集代码

下载数据采集的方法和示例

Wei Yan ASP.NET数据采集封装类,它封装了数据采集所需的所有方法

log4net的详细使用

ASP.N 优采云 采集器系统通用正则表达式

.NETC#大量发送带有附件中文发件人密件抄送电子邮件的HTML格式

.net程序中资源文件保护的讨论

C#使用代理爬网

sql生成具有指定位数的100W随机数的方法(仅用了不到1分钟的时间)(完成)

技巧:一种自动识别web爬虫的方法与流程

采集交流 • 优采云 发表了文章 • 0 个评论 • 275 次浏览 • 2020-09-01 01:20

步骤4: 如果客户端未执行重定向操作,或者cookie值不正确,则设置badcookie并将其标记为采集器.

根据上述解决方案,步骤1、2和3重复了几次,但没有超过浏览器设置的重定向限制.

根据上述方案,第一种对称加密算法是DES,TripleDES,RC2,RC4,RC5和Blowfish中的一种,第二种对称加密算法是DES,TripleDES,RC2,RC4,RC4和RC5中的一种. 与第一种对称加密算法不同.

与现有技术相比,本发明的有益效果是: 1)它可以阻止大多数静态爬虫的进入. 如果采集器无法执行主页的JS代码,则只能搜寻到服务器仅返回JS代码的主页. ,无法获得真实的首页. 2)只要采集器具有重复数据删除功能,它就不会继续搜寻,因为它会跳转到同一页面. 3)此方法的适用页面包括但不限于主页,可以在网站的任何页面中使用该页面,以有效地防止抓取采集信息.

图纸说明

图. 图1是本发明的自动识别网络爬虫的方法的示意性流程图.

具体的实现方法

下面将参考附图和特定实施例进一步详细描述本发明. 通过将javascript嵌入网页中一次或多次重定向到同一页面并同时返回状态代码,爬网程序由于重复数据删除而无法正常爬网该页面. 执行onload中javascript代码指定的cookie或badcookie,以识别请求是否来自采集器.

服务器的主页返回一个仅收录JS代码(用JavaScript编写的脚本扩展代码)的页面. 此代码位于onload函数中,并在页面完全加载后执行. 此JS代码将使用某种算法(IP,标头和其他信息作为算法参数)来设置cookie字段,然后使用window.location跳到主页(此页面). 服务器检测到该cookie有效,并返回另一个JS,它使用另一种算法来设置cookie字段. 根据网站的需要,上述步骤可以重复几次,但不能超过浏览器设置的重定向限制. 仅当所有cookie字段均有效时,才会返回常规主页URL. 如果客户端不执行重定向操作,或者cookie值不正确,则可以设置badcookie并将其标记为采集器. 同时,可以根据服务器请求记录中的请求数量将其确定为爬网程序. 例如,收录所有正确cookie的第一个get请求必须是采集器.

本发明涉及的算法是对称加密算法,主要包括DES,TripleDES,RC2,RC4,RC5和Blowfish. 为了防止用户预先访问浏览器中的页面以获得正确的cookie,可以将具有相同功能的页面添加到网站的页面目录的每个级别中,以增强防爬网效果. 查看全部

自动识别网络爬虫的方法和过程

步骤4: 如果客户端未执行重定向操作,或者cookie值不正确,则设置badcookie并将其标记为采集器.

根据上述解决方案,步骤1、2和3重复了几次,但没有超过浏览器设置的重定向限制.

根据上述方案,第一种对称加密算法是DES,TripleDES,RC2,RC4,RC5和Blowfish中的一种,第二种对称加密算法是DES,TripleDES,RC2,RC4,RC4和RC5中的一种. 与第一种对称加密算法不同.

与现有技术相比,本发明的有益效果是: 1)它可以阻止大多数静态爬虫的进入. 如果采集器无法执行主页的JS代码,则只能搜寻到服务器仅返回JS代码的主页. ,无法获得真实的首页. 2)只要采集器具有重复数据删除功能,它就不会继续搜寻,因为它会跳转到同一页面. 3)此方法的适用页面包括但不限于主页,可以在网站的任何页面中使用该页面,以有效地防止抓取采集信息.

图纸说明

图. 图1是本发明的自动识别网络爬虫的方法的示意性流程图.

具体的实现方法

下面将参考附图和特定实施例进一步详细描述本发明. 通过将javascript嵌入网页中一次或多次重定向到同一页面并同时返回状态代码,爬网程序由于重复数据删除而无法正常爬网该页面. 执行onload中javascript代码指定的cookie或badcookie,以识别请求是否来自采集器.

服务器的主页返回一个仅收录JS代码(用JavaScript编写的脚本扩展代码)的页面. 此代码位于onload函数中,并在页面完全加载后执行. 此JS代码将使用某种算法(IP,标头和其他信息作为算法参数)来设置cookie字段,然后使用window.location跳到主页(此页面). 服务器检测到该cookie有效,并返回另一个JS,它使用另一种算法来设置cookie字段. 根据网站的需要,上述步骤可以重复几次,但不能超过浏览器设置的重定向限制. 仅当所有cookie字段均有效时,才会返回常规主页URL. 如果客户端不执行重定向操作,或者cookie值不正确,则可以设置badcookie并将其标记为采集器. 同时,可以根据服务器请求记录中的请求数量将其确定为爬网程序. 例如,收录所有正确cookie的第一个get请求必须是采集器.

本发明涉及的算法是对称加密算法,主要包括DES,TripleDES,RC2,RC4,RC5和Blowfish. 为了防止用户预先访问浏览器中的页面以获得正确的cookie,可以将具有相同功能的页面添加到网站的页面目录的每个级别中,以增强防爬网效果.

技巧:碰到这类反爬虫网站,你该怎么办?

采集交流 • 优采云 发表了文章 • 0 个评论 • 172 次浏览 • 2020-09-01 00:52

只要Internet已经存在,就可以在Internet上自动进行数据刮取. 如今,公众似乎更倾向于将其称为“ Web数据采集 /网页数据爬网”,有时Web数据采集程序被称为Web爬网程序(蜘蛛). 采集常用的方法是编写一个自动程序来从Web服务器请求数据,但是大多数不擅长编写程序的朋友使用现成的常规Web爬网工具,然后解析数据以提取所需的信息.

但是,许多网页也将保护自己的数据,因此您将遇到数据捕获困难的悲剧,还有一个更令人沮丧的事情,那就是它根本无法被抓取,也许是提交给服务器. 经过妥善处理的表单被拒绝,可能是因为我的IP地址被定义为网络漫游器,或者由于未知原因而被网站阻止,无法继续访问.

但是爬网真的不可能吗? 优采云 采集器告诉您: 不!为了克服网站阻止采集或采集的一部分的困难,Web爬网工具优采云 采集器仍然非常有用. 高能量来了,请自己动手.

外国网站 采集

一些用户提到国外的网站 采集速度很慢,并且数据不能直接使用. 对于这种类型的采集,可以使用外部代理服务器. 采集的速度可以有效提高. 要将数据转换为中文,您可以使用翻译插件翻译采集.

网站请求失败

目标网站通常在接收到请求时检查Headers中的User-Agent字段. 如果没有正常的User-Agent信息,则无法传递请求. 因此,我们必须将User-Agent属性设置为不容易引起怀疑的属性. 网站中还有一个部分是为了防止盗窃,并检查请求标头中的Referer字段,因此您需要分析请求数据包捕获,并将Referer值修改为目标网站域名. 这些位于优采云 采集器中,只需直接在“其他设置”中进行修改即可. 此外,在优采云 采集器中,您可以自定义列表页面,多页面和页面标题.

经常访问被阻止

总是出现403错误?对于频繁访问相同IP或相同Cookie的用户,网站会将其识别为爬网程序并将其阻止. 这样的反爬虫可以切换cookie并控制优采云 采集器中采集的速度(盲目寻找速度). 这不是一个明智的方法. 合理的速度控制是不可打破的规则. 优采云 采集器支持进程内速度调整,实时有效),辅助代理替换IP和拨号服务器.

Cookie登录

有些网站需要输入合法的登录信息或保持登录状态才能访问所有内容. 网络采集器优采云 采集器可以响应各种情况. 一种是通过采集器的内置微浏览,第二种是通过数据包捕获分析来设置登录信息.

需要输入验证码

如何处理需要频繁输入验证码才能继续访问的网站? OCR可以在优采云 采集器中识别简单的数字验证码,但是有些验证码现在还不那么简单,因此,如果确实很复杂,则可以使用可视化的优采云浏览器在自动访问平台.

加密的网页采集

如果使用网页脚本对内容进行了加密,则可以通过模拟加密算法来恢复正在运行的脚本,或者编写用于扩展的插件. 对于技术新手来说,这种类型可能比较困难,但是您可以联系我们的优采云 采集器技术支持以寻求帮助.

上面可能列出了. 如果大神遇到其他类型的采集,您可以给我们反馈,以便我们的程序员可以为您开发更强大的功能〜 查看全部

如果遇到这种类型的防爬行动物网站,应该怎么办?

只要Internet已经存在,就可以在Internet上自动进行数据刮取. 如今,公众似乎更倾向于将其称为“ Web数据采集 /网页数据爬网”,有时Web数据采集程序被称为Web爬网程序(蜘蛛). 采集常用的方法是编写一个自动程序来从Web服务器请求数据,但是大多数不擅长编写程序的朋友使用现成的常规Web爬网工具,然后解析数据以提取所需的信息.

但是,许多网页也将保护自己的数据,因此您将遇到数据捕获困难的悲剧,还有一个更令人沮丧的事情,那就是它根本无法被抓取,也许是提交给服务器. 经过妥善处理的表单被拒绝,可能是因为我的IP地址被定义为网络漫游器,或者由于未知原因而被网站阻止,无法继续访问.

但是爬网真的不可能吗? 优采云 采集器告诉您: 不!为了克服网站阻止采集或采集的一部分的困难,Web爬网工具优采云 采集器仍然非常有用. 高能量来了,请自己动手.

外国网站 采集

一些用户提到国外的网站 采集速度很慢,并且数据不能直接使用. 对于这种类型的采集,可以使用外部代理服务器. 采集的速度可以有效提高. 要将数据转换为中文,您可以使用翻译插件翻译采集.

网站请求失败

目标网站通常在接收到请求时检查Headers中的User-Agent字段. 如果没有正常的User-Agent信息,则无法传递请求. 因此,我们必须将User-Agent属性设置为不容易引起怀疑的属性. 网站中还有一个部分是为了防止盗窃,并检查请求标头中的Referer字段,因此您需要分析请求数据包捕获,并将Referer值修改为目标网站域名. 这些位于优采云 采集器中,只需直接在“其他设置”中进行修改即可. 此外,在优采云 采集器中,您可以自定义列表页面,多页面和页面标题.

经常访问被阻止

总是出现403错误?对于频繁访问相同IP或相同Cookie的用户,网站会将其识别为爬网程序并将其阻止. 这样的反爬虫可以切换cookie并控制优采云 采集器中采集的速度(盲目寻找速度). 这不是一个明智的方法. 合理的速度控制是不可打破的规则. 优采云 采集器支持进程内速度调整,实时有效),辅助代理替换IP和拨号服务器.

Cookie登录

有些网站需要输入合法的登录信息或保持登录状态才能访问所有内容. 网络采集器优采云 采集器可以响应各种情况. 一种是通过采集器的内置微浏览,第二种是通过数据包捕获分析来设置登录信息.

需要输入验证码

如何处理需要频繁输入验证码才能继续访问的网站? OCR可以在优采云 采集器中识别简单的数字验证码,但是有些验证码现在还不那么简单,因此,如果确实很复杂,则可以使用可视化的优采云浏览器在自动访问平台.

加密的网页采集

如果使用网页脚本对内容进行了加密,则可以通过模拟加密算法来恢复正在运行的脚本,或者编写用于扩展的插件. 对于技术新手来说,这种类型可能比较困难,但是您可以联系我们的优采云 采集器技术支持以寻求帮助.

上面可能列出了. 如果大神遇到其他类型的采集,您可以给我们反馈,以便我们的程序员可以为您开发更强大的功能〜

网页数据自动抽取系统

采集交流 • 优采云 发表了文章 • 0 个评论 • 264 次浏览 • 2020-08-31 02:31

计算机工程和应用简介2004.191随着Internet的普及和WWW的广泛使用,出现了许多HTML网页. 在这些网页中,有文本网页和数据网页. 其中,大多数数据网页是由数据密集型网站发布的. 这些数据网页基本上是由后端数据库根据用户要求并使用某些脚本程序构成的. 这样的数据对于诸如电子商务中的信息获取之类的应用非常有用. 但是,由于HTML网页主要用于浏览,而不是用于操纵和使用数据,因此其中的数据很难被应用程序直接使用. 尽管XMLeXtensibeMarketLanguage语言克服了HTML的一些缺点,但是由于Internet上存在大量的历史数据,并且到目前为止,大多数网页仍是HTML页面,但从网络中提取数据仍然很复杂且困难. 页面并将它们传递给应用程序. 但这是一项有意义的任务. 从网页提取数据通常是由包装程序完成的. 所谓的包装器是一种软件程序,可以从HTML网页中提取数据并将其还原为结构化数据,例如XML数据. 编写包装的方法已经历了三个阶段: 手动编写,半自动生成和正在研究的全自动生成. 在手动编写阶段,具有一定知识的专业专业人员首先分析网页,然后编写包装. 在现阶段,对这类专业人员的要求很高,而且任务艰巨. 通过使用人工智能技术,在一定程度上采用了机器学习14,数据挖掘56和概念建模7等方法,以使包装材料的生产能够自动进行. 然而,在这些技术中,不仅需要提供用户设置的识别样本,而且还需要具有一定的先验知识. 在过去的一年中,已经提出了两种基本上可以完全自动化的方法. 89只要输入相应的网页,这两种方法就可以自动分析和生成包装器并从网页中提取数据. 在整个过程中唯一需要用户干预的地方是最终数据结构的语义分析部分.

采用这种全自动方法可以大大减少用户的工作量,并大大改善网页提取工作. 但是这两种方法也有某些缺点. 其中,Road-Runner8系统中的ALIGN算法根据比较示例页面的HTML代码的匹配部分和不匹配部分确定通用包装器,但是在这种匹配过程中,该算法只是将HTML代码视为字符串流. 为了进行比较,它没有使用HTML代码的某些结构特征来使其对可重复项的处理更加复杂. EXALG算法9的核心是查找和确定网页之间最大的频繁发生等价类. 然后,大型且频繁发生的Euivaencecasses会基于此类生成模板. 提取数据通过对算法实验数据的分析,发现该算法提取的数据在结构上存在一定问题. 有一定的自动Web数据提取系统用于确定可重复项. 王如1宋汉涛1陆玉昌21北京工业大学计算机科学学院,北京1000812,清华大学,智能技术与系统国家重点实验室,北京摘要互联网上有大量的半结构化HTML网页. 为了使用这些丰富的网页数据,有必要再次从网页中提取数据. 本文介绍了一种基于树结构和自动生成包装器的系统的新信息提取方法DAEDOMbasedAutomaticExtraction,该方法将HTML网页数据转换为XML数据. 提取过程基本上不需要人工干预,从而实现了提取过程. 自动化.

此方法可以应用于信息搜索代理或数据集成系统. 关键词包装的摘录信息生成DOM树文章文档代号419 013 504 CLC TP311AnAutomaticWebDataExtractionSystemWangRu1SongHantao1LuYuchang21Dep中国extractthedatafrompages.AnautomaticwebpagesdataextractionsystemDAEispresentsinthis paperandanewtreebasedmethodofinformationextractionisasoproposed.Inthissystemthewra pperisautomaticaygeneratedandtheHTMLwebpagesdatacanbeautomaticaytransformedinto XMLformat.KeywordsdataextractionwrappergenerationDOMtree的t.ofComputerBeijingInstituteofTechnoogyBeijing1000812StateKeyLabofInteigentTechno ogyandSystemDept.ofComputerTsinghuaUniversityBeijing100084AbstractThereareaotof HTMLwebpagesintheInternet.Thesepageshavesomestructuresandtheyaredynamicaygener atedusingscriptsfromthecontentofbackedendDBMS.Ifpeopewanttousethesedatatheyhaveto国家自然科学基金资助项目编号: 79990580国家973重点基础研究发展计划项目号G1998030414作者简介王儒博士19722000研究是异构数据库互连的主要研究方向.

宋汉涛教授1940年担任博士生导师的主要研究方向是异构数据库和无线移动网络的互连和使用. 陆玉昌教授在1937年的主要研究方向是机器学习和KDD. 1352004.19计算机工程和应用程序错误. 迄今为止,国内的研究基本上处于包装器的半自动生成阶段,关于自动识别网页并生成包装器提取数据的方法尚无相关研究数据. 在中国,最典型的系统和算法是基于中国人民大学数据与知识研究所提出的预定义模式的1个包装器. 在图11中,用户定义了模式并给出了模式与HTML网页之间的映射关系. 然后系统导出规则并同时生成包装器. 2中国科学院软件提出的基于DOM的信息12该算法基于文档对象模型DOM,并使用DOM层次结构中要提取的信息的路径作为信息提取的“坐标”,并进行设计基于此基本原理的算法. 归纳学习算法用于半自动生成提取规则,然后根据提取规则生成JAVA类. 此类用作Web数据源包装器的重要组件. 3河北大学基于样本实例的Web信息提取13用户首先基于OR模型选择样本页面和预定义模式,然后在样本页面中标记样本页面和样本记录,学习形成包括提取规则和关联规则的规则,并放入规则,然后输入知识库,最后使用知识库从其他类似页面中自动提取信息,并将其存储在对象关系数据库中.

4中国科学技术大学提出的基于多层模型的多记录网页信息提取方法14基本思想是HTML网页信息提取仅由多层描述模型,以便可以使用各层之间的互连特性来帮助动态获取与每层HTML页面内容的特定描述格式密切相关的信息识别模式的知识,并最终使用获得的多层信息识别模式来完成每个HTML页面的特定信息提取工作. 这些算法有一定的局限性. 首先,需要更多的手动干预. 由于需要更多的先验知识和不同系统使用的不同描述语言,需要干预的人员不仅需要熟悉网页的结构分析和生成,还需要对使用的描述语言有更好的理解通过系统. 要求比较严格. 其次,基于某些先验知识生成包装器的方法导致系统的适应性较差. 也就是说,根据特定情况生成的包装器只能应用于特定情况. 当网页结构更改时,需要重新手动执行. 因此,干预和识别很难很好地适应变化. 本文提出了一种基于DAEDOM的新系统,该系统可自动生成包装器. 系统中的核心算法借鉴了ALIGN算法的一些思想,但已得到很大改进. DAE系统利用HTML代码的树状特征来更好地解决确定可重复项和可选项的问题,特别是对于嵌套数据的提取而言,更为方便. DAE系统在数据语义分析中还具有一些独特的功能. 包装程序的整个生成和数据提取过程是自动的,除了需要用户参与的语义分析.

此系统是WebMEWebMiningEnvironment系统的一部分. 它是作者设计的网络数据定制,自动采集,过滤,填充,格式转换,异构集成,存储,分类和聚类,模式提取和高效检索的集合. ,网络导航,信息定制和推荐,数据挖掘支持等功能,构成了整个网络挖掘原型系统. 2系统概述DAE系统是WebMEWebMiningEnvironment系统的一部分. WebME系统首先使用信息定制方法从相应的网站下载网页,然后使用唯一的网页分类方法对网页进行分类. 对于数据网页,请使用DAE算法从分类的网页中提取数据. 数据存储在结构化的数据结构中,然后对数据进行挖掘和使用. 对于文本网页,使用文本分类方法和倒排方法来索引要搜索的网页. DAE系统主要从基于数据的网页中提取数据. 所谓数据类型网页,是指由后端数据库针对不同的用户查询,并使用某种脚本语言返回结果的网页. 数据提取问题的标准化定义是10“给几个相同类型的示例网页以找出其源数据集的嵌套结构并从这些网页中提取源数据集”. 如图1所示,用于两个网页的DAE算法比较两个网页之间的相似性和差异,以获得一个公共包装,然后将其与更多的示例网页进行比较,以生成此类网页的包装. 经过语义分析和数据模型生成之后,使用包装程序提取数据并将其与数据模型组合以存储在结构化XML数据集中. 数据存储在XML数据集中,因为XML数据格式是Internet上数据交换的标准形式,并且XML数据也可以轻松转换为关系数据库. 这样,数据的共享和使用可用于以数据集中XMLSchema的形式定义数据的结构. 数据的语义在系统的最后部分确定.

DAE系统由4个部分组成,系统结构如图2所示. 1用于包装和数据模式的系统中的数据预处理DP图1数据类型网页示例136计算机工程和应用2004.19生成主要取决于由于HTML文档采用树状语法结构,因此首先将HTML文档转换为HTM树一种具有自定义形式的树模型. 在此模块中,由于并非所有网页都严格遵循XHTML规范,因此需要纠正网页中的某些不规则之处. 模块结束后,将输出HTM树. 2对包装器的分析和AGW的生成是系统的核心部分. 在此模块中,包装是通过比较不匹配的不同网页来确定的. 同时,根据生成的包装器生成数据模式. 在此过程中,使用HTM树的父子节点和同级节点之间的某些固有关系会大大降低确定数据选项和可重复项的难度. 3数据项的语义分析DSA的数据提取不仅是从网页中简单地提取数据,而且还需要赋予数据项某种语义. 通过对HTML网页的分析,可以发现通常在数据项的前面有一些数据项的描述,这些描述可以用来确定数据项的语义. 在HTM树中,这一点尤其明显. 数据项的描述部分通常可以在数据项节点的相邻兄弟节点或祖先节点上找到. 由于无法自动完成数据项的语义分析,因此此任务需要用户的参与. 用户最终可以根据系统提供的相关语义信息来确定数据项的语义.

4数据提取和存储DEM生成包装器并且已对数据项进行语义分析时,可以在输入网页上执行数据提取. 提取的数据以XML格式存储,并与相应的XMLSchema模式链接. 图2 DAE系统的体系结构在整个系统的工作过程中,除了需要用户参与的语义分析部分外,其余部分均由程序自动完成,从而大大提高了自动化程度. 3包装程序的分析和生产AGW包装程序可以看作是一些特殊程序,可以自动从网站提取数据并将信息转换为结构化形式. 生成包装器的工具可以分类如下: 10种包装器开发语言,基于HTML内部结构的工具,基于NLP的工具,用于包装器推理的工具,基于建模的工具,基于本体的工具等. 该系统使用了基于HTML内部结构的分析和生成方法,该方法类似于RoadRunner系统中的ALIGN算法,但比ALIGN算法有更大的改进. 3.1理论基础HTML文档的嵌套类型与无联合正则表达式之间存在完全的对应关系. 如果给定了一组HTML字符串s1s2 ... sk,则它对应于源数据集的编码,也就是说,可以通过推导最小无联合来表示嵌套类型实例集i1i2 ... ik. 正则表达式输入收录字符串s1s2 ... sk的语言l以获取类型.

因此,它可用作包装器来解析字符串s1s2 ... sk并重建源数据集i1i2 ... ik,以便模式发现和数据提取等效于找到最小的无联合正则表达式无联盟的正则表达式语言收录输入字符串s1s2 ... sk. 由于所研究的htm网页具有严格的嵌套和标识符配对结构,因此定义了HTT树来表示网页的正则表达式. HTT树的定义如下. 1htm网页的基本单位标记是一个标识符. 标识符是一对,或者字符串是只有一个叶节点的HTT树. 2如果网页的形式为B1 ... Bn,即B1 ... Bn为n个HTT树,则形成一个以n个子树B1 ... Bn为根的HTT树. 3可选表达式r对应于以OPTIONAL为根,r为子树的树. 4重复表达式r对应于以ITERATOR为根,r为子树的树. HTT树不仅可以表示HTML网页,还可以表示一种网页生成模板. 如图3所示,有两个网页和HTT树,以及相应的模板和HTT树. 图3网页及其相应的HTT树3.2实现技术AGW算法AGW算法借鉴了RoanRunner系统中ALIGN算法的一些思想. 主要处理工作是同时比较和校正两个输入的HTT树之间的不同节点. 最小的HTT树.

算法的输入是一组示例网页. 每次将包装树与示例网页树进行比较并生成新的包装树时,然后将包装树与另一个示例网页树进行比较,直到将所有包装树都进行比较. 在比较包装树和示例网页树的过程中,这两种树是通过预遍历方法同时处理的. 如果两个树中的节点相同,则处理下一个节点,直到比较并处理所有节点为止. 完成后,将生成新的包装器HTT树. 在遍历和比较过程中,存在两种基本类型的不匹配字符串不匹配和标识符不匹配. 1372004.19计算机工程与应用程序匹配. 因为这两个不匹配的原因不同,所以它们对包装器和数据模式的影响也不同. 字符串不匹配在属于同一类别的两个不同的网页中,字符串不匹配是由数据库字段的不同值引起的. 因此,如果存在字符串不匹配,则可以认为它对应于数据库中的字段. 处理方法是在包装器中将此位置标记为PCDATA,并认为在数据模式下此处存在一个字段. 如图3所示,“ wangru”和“ Louis”属于字符串不匹配,因此包装程序指示PCDATA数据模式中存在一个字段. 标识符不匹配标识符不匹配是指包装器和示例网页之间的HTML标识符不匹配,或左侧包装器中“ LI”下的标识符和单词之间的不匹配,中间示例网页“ LI”中有两个子项,其中有三个子项,因此遍历和搜索图层时会出现标识符不匹配的情况.

这样做的原因是因为这里有重复的数据项. 另一种可能性是这里有一个可选项,即数据项是可选的. 该算法首先判断它是否是数据项的重复,如果不是,则判断它是否是可选的. 遍历结束后,将生成新的包装树,并处理所有示例网页以生成最终的包装树. 根据包装树,生成包装,并且基于树的层次关系,可以容易地确定这种网页的数据模式,并且可以提供有价值的语义分析数据. 如图4所示,图3中提取的数据及其数据模型已添加了语义. AGW算法使用HTT树作为基本表示模型. 使用该模型不仅实现了HTML网页的抽象,而且在算法的实现中充分利用了树本身的某些节点之间的关系,从而提高了算法的性能,降低了算法的时间复杂度. . 4结束语为了适应在线数据更改的动态需求,生成包装器的算法可以具有更高的自动化和适应性. 本文提出了一种新的自动生成包装器的系统,即基于DAEDOM的自动提取. 该系统是WebMEWebMiningEnvironment系统的一部分. 与RoadRunner系统中的ALIGN算法相比,它有了很大的改进. DAE系统使用HTML代码的树状特征来更好地解决确定可重复项和可选项的问题,特别是对于嵌套数据的提取而言,这样做更加方便,同时增加了数据提取的灵活性并减少了部分内容. 数据提取. DAE系统的时间复杂度在数据语义分析中也具有一些独特的功能.

下一步将要进行的工作是分析提取的数据项的语义一致性. 收到2003年9月参考1.CHsuMDung.Generatingfinite-statetransducersforsemistructureddataextractionfromthe webJ.InformationSystem19982382.NKushmerik.WrapperinductionEfficiencyandexpressi venessJ.Arti-ficialIntelligence20001183.IMusleaSMintonCAKnobolock.Ahierarchicalap proachtowra-pperinductionC.InProcofAutonomousAgents19994.SSoderland.Learninginf ormationextractionrulesforsemistructuredandfreetextJ.MachineLearning1999341-35.BAd elberg. 结节-atoolforsemi-automaticallyextractingstructuredandsemistructureddatafro mtextdocuments.InSIGMOD986.BARibeiro-NetoALaender.Extractingsemistructureddat athroughexample.InCIKM997.DWEmbleyDMCampbell.Aconceptual-modelingapproach toextractingdatafromtheweb.InER988.VCrescenziGMecca.RoadRunnerTowardsautomati cdataextractionfromlargewebsitesC.In27thVLDB20019.ArvindArasuHectorGarcia - 莫林a.ExtractingstructureddatafromwebpagesR.TechnicalReportStanfordUniversity200210.Al bertoHLaenderBerthierARibeiro-Neto.ABriefSurveyofWebDataExtractionToolsJ. Acms IGMODRecord200231211. 孟小峰,王海燕,顾明哲等. 基于XWIS J中预定义模式的包装器. 计算机应用程序2001-0912. 李晓东顾玉清. 基于DOM的Web信息提取J. Computer Journal 2002-0513. 张少华徐林浩杨文柱. 基于样本实例Web信息抽取的研究. 河北大学学报自然科学版2001414. 基于多层模式的多记录网页信息提取方法J.计算机工程信息技术. 2003年,路易斯·伊斯特德2002年第二版. 2003图4生成数据模式并提取数据138 查看全部

网页数据自动提取系统

计算机工程和应用简介2004.191随着Internet的普及和WWW的广泛使用,出现了许多HTML网页. 在这些网页中,有文本网页和数据网页. 其中,大多数数据网页是由数据密集型网站发布的. 这些数据网页基本上是由后端数据库根据用户要求并使用某些脚本程序构成的. 这样的数据对于诸如电子商务中的信息获取之类的应用非常有用. 但是,由于HTML网页主要用于浏览,而不是用于操纵和使用数据,因此其中的数据很难被应用程序直接使用. 尽管XMLeXtensibeMarketLanguage语言克服了HTML的一些缺点,但是由于Internet上存在大量的历史数据,并且到目前为止,大多数网页仍是HTML页面,但从网络中提取数据仍然很复杂且困难. 页面并将它们传递给应用程序. 但这是一项有意义的任务. 从网页提取数据通常是由包装程序完成的. 所谓的包装器是一种软件程序,可以从HTML网页中提取数据并将其还原为结构化数据,例如XML数据. 编写包装的方法已经历了三个阶段: 手动编写,半自动生成和正在研究的全自动生成. 在手动编写阶段,具有一定知识的专业专业人员首先分析网页,然后编写包装. 在现阶段,对这类专业人员的要求很高,而且任务艰巨. 通过使用人工智能技术,在一定程度上采用了机器学习14,数据挖掘56和概念建模7等方法,以使包装材料的生产能够自动进行. 然而,在这些技术中,不仅需要提供用户设置的识别样本,而且还需要具有一定的先验知识. 在过去的一年中,已经提出了两种基本上可以完全自动化的方法. 89只要输入相应的网页,这两种方法就可以自动分析和生成包装器并从网页中提取数据. 在整个过程中唯一需要用户干预的地方是最终数据结构的语义分析部分.

采用这种全自动方法可以大大减少用户的工作量,并大大改善网页提取工作. 但是这两种方法也有某些缺点. 其中,Road-Runner8系统中的ALIGN算法根据比较示例页面的HTML代码的匹配部分和不匹配部分确定通用包装器,但是在这种匹配过程中,该算法只是将HTML代码视为字符串流. 为了进行比较,它没有使用HTML代码的某些结构特征来使其对可重复项的处理更加复杂. EXALG算法9的核心是查找和确定网页之间最大的频繁发生等价类. 然后,大型且频繁发生的Euivaencecasses会基于此类生成模板. 提取数据通过对算法实验数据的分析,发现该算法提取的数据在结构上存在一定问题. 有一定的自动Web数据提取系统用于确定可重复项. 王如1宋汉涛1陆玉昌21北京工业大学计算机科学学院,北京1000812,清华大学,智能技术与系统国家重点实验室,北京摘要互联网上有大量的半结构化HTML网页. 为了使用这些丰富的网页数据,有必要再次从网页中提取数据. 本文介绍了一种基于树结构和自动生成包装器的系统的新信息提取方法DAEDOMbasedAutomaticExtraction,该方法将HTML网页数据转换为XML数据. 提取过程基本上不需要人工干预,从而实现了提取过程. 自动化.

此方法可以应用于信息搜索代理或数据集成系统. 关键词包装的摘录信息生成DOM树文章文档代号419 013 504 CLC TP311AnAutomaticWebDataExtractionSystemWangRu1SongHantao1LuYuchang21Dep中国extractthedatafrompages.AnautomaticwebpagesdataextractionsystemDAEispresentsinthis paperandanewtreebasedmethodofinformationextractionisasoproposed.Inthissystemthewra pperisautomaticaygeneratedandtheHTMLwebpagesdatacanbeautomaticaytransformedinto XMLformat.KeywordsdataextractionwrappergenerationDOMtree的t.ofComputerBeijingInstituteofTechnoogyBeijing1000812StateKeyLabofInteigentTechno ogyandSystemDept.ofComputerTsinghuaUniversityBeijing100084AbstractThereareaotof HTMLwebpagesintheInternet.Thesepageshavesomestructuresandtheyaredynamicaygener atedusingscriptsfromthecontentofbackedendDBMS.Ifpeopewanttousethesedatatheyhaveto国家自然科学基金资助项目编号: 79990580国家973重点基础研究发展计划项目号G1998030414作者简介王儒博士19722000研究是异构数据库互连的主要研究方向.

宋汉涛教授1940年担任博士生导师的主要研究方向是异构数据库和无线移动网络的互连和使用. 陆玉昌教授在1937年的主要研究方向是机器学习和KDD. 1352004.19计算机工程和应用程序错误. 迄今为止,国内的研究基本上处于包装器的半自动生成阶段,关于自动识别网页并生成包装器提取数据的方法尚无相关研究数据. 在中国,最典型的系统和算法是基于中国人民大学数据与知识研究所提出的预定义模式的1个包装器. 在图11中,用户定义了模式并给出了模式与HTML网页之间的映射关系. 然后系统导出规则并同时生成包装器. 2中国科学院软件提出的基于DOM的信息12该算法基于文档对象模型DOM,并使用DOM层次结构中要提取的信息的路径作为信息提取的“坐标”,并进行设计基于此基本原理的算法. 归纳学习算法用于半自动生成提取规则,然后根据提取规则生成JAVA类. 此类用作Web数据源包装器的重要组件. 3河北大学基于样本实例的Web信息提取13用户首先基于OR模型选择样本页面和预定义模式,然后在样本页面中标记样本页面和样本记录,学习形成包括提取规则和关联规则的规则,并放入规则,然后输入知识库,最后使用知识库从其他类似页面中自动提取信息,并将其存储在对象关系数据库中.

4中国科学技术大学提出的基于多层模型的多记录网页信息提取方法14基本思想是HTML网页信息提取仅由多层描述模型,以便可以使用各层之间的互连特性来帮助动态获取与每层HTML页面内容的特定描述格式密切相关的信息识别模式的知识,并最终使用获得的多层信息识别模式来完成每个HTML页面的特定信息提取工作. 这些算法有一定的局限性. 首先,需要更多的手动干预. 由于需要更多的先验知识和不同系统使用的不同描述语言,需要干预的人员不仅需要熟悉网页的结构分析和生成,还需要对使用的描述语言有更好的理解通过系统. 要求比较严格. 其次,基于某些先验知识生成包装器的方法导致系统的适应性较差. 也就是说,根据特定情况生成的包装器只能应用于特定情况. 当网页结构更改时,需要重新手动执行. 因此,干预和识别很难很好地适应变化. 本文提出了一种基于DAEDOM的新系统,该系统可自动生成包装器. 系统中的核心算法借鉴了ALIGN算法的一些思想,但已得到很大改进. DAE系统利用HTML代码的树状特征来更好地解决确定可重复项和可选项的问题,特别是对于嵌套数据的提取而言,更为方便. DAE系统在数据语义分析中还具有一些独特的功能. 包装程序的整个生成和数据提取过程是自动的,除了需要用户参与的语义分析.

此系统是WebMEWebMiningEnvironment系统的一部分. 它是作者设计的网络数据定制,自动采集,过滤,填充,格式转换,异构集成,存储,分类和聚类,模式提取和高效检索的集合. ,网络导航,信息定制和推荐,数据挖掘支持等功能,构成了整个网络挖掘原型系统. 2系统概述DAE系统是WebMEWebMiningEnvironment系统的一部分. WebME系统首先使用信息定制方法从相应的网站下载网页,然后使用唯一的网页分类方法对网页进行分类. 对于数据网页,请使用DAE算法从分类的网页中提取数据. 数据存储在结构化的数据结构中,然后对数据进行挖掘和使用. 对于文本网页,使用文本分类方法和倒排方法来索引要搜索的网页. DAE系统主要从基于数据的网页中提取数据. 所谓数据类型网页,是指由后端数据库针对不同的用户查询,并使用某种脚本语言返回结果的网页. 数据提取问题的标准化定义是10“给几个相同类型的示例网页以找出其源数据集的嵌套结构并从这些网页中提取源数据集”. 如图1所示,用于两个网页的DAE算法比较两个网页之间的相似性和差异,以获得一个公共包装,然后将其与更多的示例网页进行比较,以生成此类网页的包装. 经过语义分析和数据模型生成之后,使用包装程序提取数据并将其与数据模型组合以存储在结构化XML数据集中. 数据存储在XML数据集中,因为XML数据格式是Internet上数据交换的标准形式,并且XML数据也可以轻松转换为关系数据库. 这样,数据的共享和使用可用于以数据集中XMLSchema的形式定义数据的结构. 数据的语义在系统的最后部分确定.

DAE系统由4个部分组成,系统结构如图2所示. 1用于包装和数据模式的系统中的数据预处理DP图1数据类型网页示例136计算机工程和应用2004.19生成主要取决于由于HTML文档采用树状语法结构,因此首先将HTML文档转换为HTM树一种具有自定义形式的树模型. 在此模块中,由于并非所有网页都严格遵循XHTML规范,因此需要纠正网页中的某些不规则之处. 模块结束后,将输出HTM树. 2对包装器的分析和AGW的生成是系统的核心部分. 在此模块中,包装是通过比较不匹配的不同网页来确定的. 同时,根据生成的包装器生成数据模式. 在此过程中,使用HTM树的父子节点和同级节点之间的某些固有关系会大大降低确定数据选项和可重复项的难度. 3数据项的语义分析DSA的数据提取不仅是从网页中简单地提取数据,而且还需要赋予数据项某种语义. 通过对HTML网页的分析,可以发现通常在数据项的前面有一些数据项的描述,这些描述可以用来确定数据项的语义. 在HTM树中,这一点尤其明显. 数据项的描述部分通常可以在数据项节点的相邻兄弟节点或祖先节点上找到. 由于无法自动完成数据项的语义分析,因此此任务需要用户的参与. 用户最终可以根据系统提供的相关语义信息来确定数据项的语义.

4数据提取和存储DEM生成包装器并且已对数据项进行语义分析时,可以在输入网页上执行数据提取. 提取的数据以XML格式存储,并与相应的XMLSchema模式链接. 图2 DAE系统的体系结构在整个系统的工作过程中,除了需要用户参与的语义分析部分外,其余部分均由程序自动完成,从而大大提高了自动化程度. 3包装程序的分析和生产AGW包装程序可以看作是一些特殊程序,可以自动从网站提取数据并将信息转换为结构化形式. 生成包装器的工具可以分类如下: 10种包装器开发语言,基于HTML内部结构的工具,基于NLP的工具,用于包装器推理的工具,基于建模的工具,基于本体的工具等. 该系统使用了基于HTML内部结构的分析和生成方法,该方法类似于RoadRunner系统中的ALIGN算法,但比ALIGN算法有更大的改进. 3.1理论基础HTML文档的嵌套类型与无联合正则表达式之间存在完全的对应关系. 如果给定了一组HTML字符串s1s2 ... sk,则它对应于源数据集的编码,也就是说,可以通过推导最小无联合来表示嵌套类型实例集i1i2 ... ik. 正则表达式输入收录字符串s1s2 ... sk的语言l以获取类型.

因此,它可用作包装器来解析字符串s1s2 ... sk并重建源数据集i1i2 ... ik,以便模式发现和数据提取等效于找到最小的无联合正则表达式无联盟的正则表达式语言收录输入字符串s1s2 ... sk. 由于所研究的htm网页具有严格的嵌套和标识符配对结构,因此定义了HTT树来表示网页的正则表达式. HTT树的定义如下. 1htm网页的基本单位标记是一个标识符. 标识符是一对,或者字符串是只有一个叶节点的HTT树. 2如果网页的形式为B1 ... Bn,即B1 ... Bn为n个HTT树,则形成一个以n个子树B1 ... Bn为根的HTT树. 3可选表达式r对应于以OPTIONAL为根,r为子树的树. 4重复表达式r对应于以ITERATOR为根,r为子树的树. HTT树不仅可以表示HTML网页,还可以表示一种网页生成模板. 如图3所示,有两个网页和HTT树,以及相应的模板和HTT树. 图3网页及其相应的HTT树3.2实现技术AGW算法AGW算法借鉴了RoanRunner系统中ALIGN算法的一些思想. 主要处理工作是同时比较和校正两个输入的HTT树之间的不同节点. 最小的HTT树.

算法的输入是一组示例网页. 每次将包装树与示例网页树进行比较并生成新的包装树时,然后将包装树与另一个示例网页树进行比较,直到将所有包装树都进行比较. 在比较包装树和示例网页树的过程中,这两种树是通过预遍历方法同时处理的. 如果两个树中的节点相同,则处理下一个节点,直到比较并处理所有节点为止. 完成后,将生成新的包装器HTT树. 在遍历和比较过程中,存在两种基本类型的不匹配字符串不匹配和标识符不匹配. 1372004.19计算机工程与应用程序匹配. 因为这两个不匹配的原因不同,所以它们对包装器和数据模式的影响也不同. 字符串不匹配在属于同一类别的两个不同的网页中,字符串不匹配是由数据库字段的不同值引起的. 因此,如果存在字符串不匹配,则可以认为它对应于数据库中的字段. 处理方法是在包装器中将此位置标记为PCDATA,并认为在数据模式下此处存在一个字段. 如图3所示,“ wangru”和“ Louis”属于字符串不匹配,因此包装程序指示PCDATA数据模式中存在一个字段. 标识符不匹配标识符不匹配是指包装器和示例网页之间的HTML标识符不匹配,或左侧包装器中“ LI”下的标识符和单词之间的不匹配,中间示例网页“ LI”中有两个子项,其中有三个子项,因此遍历和搜索图层时会出现标识符不匹配的情况.

这样做的原因是因为这里有重复的数据项. 另一种可能性是这里有一个可选项,即数据项是可选的. 该算法首先判断它是否是数据项的重复,如果不是,则判断它是否是可选的. 遍历结束后,将生成新的包装树,并处理所有示例网页以生成最终的包装树. 根据包装树,生成包装,并且基于树的层次关系,可以容易地确定这种网页的数据模式,并且可以提供有价值的语义分析数据. 如图4所示,图3中提取的数据及其数据模型已添加了语义. AGW算法使用HTT树作为基本表示模型. 使用该模型不仅实现了HTML网页的抽象,而且在算法的实现中充分利用了树本身的某些节点之间的关系,从而提高了算法的性能,降低了算法的时间复杂度. . 4结束语为了适应在线数据更改的动态需求,生成包装器的算法可以具有更高的自动化和适应性. 本文提出了一种新的自动生成包装器的系统,即基于DAEDOM的自动提取. 该系统是WebMEWebMiningEnvironment系统的一部分. 与RoadRunner系统中的ALIGN算法相比,它有了很大的改进. DAE系统使用HTML代码的树状特征来更好地解决确定可重复项和可选项的问题,特别是对于嵌套数据的提取而言,这样做更加方便,同时增加了数据提取的灵活性并减少了部分内容. 数据提取. DAE系统的时间复杂度在数据语义分析中也具有一些独特的功能.

下一步将要进行的工作是分析提取的数据项的语义一致性. 收到2003年9月参考1.CHsuMDung.Generatingfinite-statetransducersforsemistructureddataextractionfromthe webJ.InformationSystem19982382.NKushmerik.WrapperinductionEfficiencyandexpressi venessJ.Arti-ficialIntelligence20001183.IMusleaSMintonCAKnobolock.Ahierarchicalap proachtowra-pperinductionC.InProcofAutonomousAgents19994.SSoderland.Learninginf ormationextractionrulesforsemistructuredandfreetextJ.MachineLearning1999341-35.BAd elberg. 结节-atoolforsemi-automaticallyextractingstructuredandsemistructureddatafro mtextdocuments.InSIGMOD986.BARibeiro-NetoALaender.Extractingsemistructureddat athroughexample.InCIKM997.DWEmbleyDMCampbell.Aconceptual-modelingapproach toextractingdatafromtheweb.InER988.VCrescenziGMecca.RoadRunnerTowardsautomati cdataextractionfromlargewebsitesC.In27thVLDB20019.ArvindArasuHectorGarcia - 莫林a.ExtractingstructureddatafromwebpagesR.TechnicalReportStanfordUniversity200210.Al bertoHLaenderBerthierARibeiro-Neto.ABriefSurveyofWebDataExtractionToolsJ. Acms IGMODRecord200231211. 孟小峰,王海燕,顾明哲等. 基于XWIS J中预定义模式的包装器. 计算机应用程序2001-0912. 李晓东顾玉清. 基于DOM的Web信息提取J. Computer Journal 2002-0513. 张少华徐林浩杨文柱. 基于样本实例Web信息抽取的研究. 河北大学学报自然科学版2001414. 基于多层模式的多记录网页信息提取方法J.计算机工程信息技术. 2003年,路易斯·伊斯特德2002年第二版. 2003图4生成数据模式并提取数据138

3人团队,如何管理10万采集网站?(最全、最细解读)

采集交流 • 优采云 发表了文章 • 0 个评论 • 286 次浏览 • 2020-08-30 22:04

首先: 构建源系统

由于我们提供舆论监测服务,因此我们的采访范围相对广泛,包括(尽可能)包括我们行业中的所有网站,以及该国发布的主要和次要媒体. 各种派对媒体,纸质媒体,应用程序等,以及社交媒体网站,例如微博,微信和论坛.

网站,列管理

现在我们的采集大约涵盖6W网站,并且每天都在不断增加. 我们如何管理如此大量的网站?这就是源系统的价值!

我们在源系统中管理需要采集的网站以及需要采集的通道或列. 同时,某些网站媒体类别,行业类别,网站类型等都在系统中进行管理.

同时,为了提高网站和列的配置效率,我们支持将列的HTML源代码直接复制到系统中,然后自动分析列名,列URL,正则表达式列下的数据和其他数据. 通过这种优化,每个人每天配置大约20个网站,但现在已增加到100个以上.

关键字搜索

数据采集,除了直接发布信息采集的网站外,另一种快速获取数据的方法是在主要搜索引擎采集中搜索关键词,例如百度,搜狗,360和其他公司的搜索引擎.

在源系统中,除了上述两种类型的采集源外,它还可以管理服务器,部署的采集器等. 因为在大量采集中,有数百台服务器,而三,五台或每个服务器上甚至部署了十或二十个爬虫. 这些采集器的上载,部署,启动和关闭也既费时又耗能. 事情. 通过系统的统一管理,可以大大减少部署,运维和维护的时间,并可以降低很多成本.

第二: 建立网站监控系统

这部分主要包括两个部分: 一个是监视网站或列的状态(可以正常访问);另一个是对常规信息的监视;

网站,列的状态监控

1: 自动化

通常情况下,它是通过自动方式每两周或一个月检查一次所有网站.

然后返回状态码不是200,然后再次执行第二和第三次检查. 主要目的是防止由于网络问题或网站响应问题引起的监视失败,并增加人工二次处理的时间;

根据验证码,删除404、403和其他类型,以及502,一段时间后将再次检查未记录的域名和其他类型. 但是请记住同步关闭网站的这些采集,否则采集效率会大大降低.

2: 传递结果数据

如果您有10W网站,则每次执行自动验证都非常耗时. 为了提高效率,我们可以结合采集结果进行处理. 根据采集的结果数据,我们首先分析最近一周哪些列没有采集数据,然后自动验证这些网站,这将大大提高效率.

3: 爬行动物监控

当然,我们也可以在解析HTML源代码时标记采集器数据. 如果网站没有响应,则直接保存任务的ID,然后在源系统中进行标记,运维人员可以实时查看网站的状态并及时处理,以提高数据采集的效率.

同时,如果网站正常返回数据,但未解析任何信息,则该任务可能是常规异常,也可能是网站异常. 需要第二次测试.

正则表达式验证

如上所述,在采集中,我们可以通过当前列或网站记录是否根据现有的正则表达式对数据进行了解析,如果不是,则在徽标上将源系统中的相应列记录下来.

同时,有必要建立一种服务,该服务可自动识别列的正则表达式,每隔一段时间(例如30分钟)读取一次已识别的记录,自动识别正则表达式并进行同步到采集队列.

为了确保正则表达式的正确性,在自动识别并同步到采集队列后,如果仍然没有匹配信息. 此时,系统需要提示运维人员进行手工分析.

第三: 数据补充

在民意监测中,无论您涵盖的采集范围如何,总是会有一些数据. 您没有采集,但是可以看到. 这时,我要求改善客户体验,我们需要密切注意手动补充记录到系统中,然后?

然后,我们首先需要分析我们的网站是否已配置,列是否已正确配置以及正则表达式是否正确. 通过对这些步骤的检查,可以找到错过采矿的原因. 根据原因,优化源或完善采集器.

数据补充可以及时减少客户的不满意,同时可以改善源和采集,从而实现闭环采集.

第四: 自动化

首先: 智能识别采集频率

现在我们的网站和列采集的频率仍然是固定频率,因此一些信息更新相对较低或无效的列采集的网站将大大降低采集效率. 这会导致频繁的网站或列采集延迟,从而无法更新信息,从而降低了数据价值.

我们现在正在基于每个站点或带有采集数据的列的发布时间分布,统计分析更合适的采集频率,以最大程度地减少服务器资源的浪费并提高采集效率并最大化数据价值.

第二: 智能识别网站专栏

我们的采集网站约为6W,专栏约为70W. 这些6W网站,每天都有许多网站升级和修订,货架上有大量新柱子,旧柱子已经下架. 仅3人的运维团队就无法完成这些工作负载.

因此,我们根据6W网站中配置的列对它们进行训练,然后每周分析一次网站以自动识别列. 然后,筛选出与我的业务无关的列,最后进行手动抽样检查,最后将其发布到用于采集的采集队列. 这样,我们的运维团队已从9人减少到3人. 它还可以确保采集的稳定性和效率.

如今,当大数据流行时,所有分析的基础都是数据.

随着人工智能时代的到来,人类可以做的事几乎都可以由机器代替.

那么,在30至50年内,机器人能击败人类吗?哈哈... 查看全部

如何在3人团队中管理100,000个采集网站? (最完整,最详尽的解释)

首先: 构建源系统

由于我们提供舆论监测服务,因此我们的采访范围相对广泛,包括(尽可能)包括我们行业中的所有网站,以及该国发布的主要和次要媒体. 各种派对媒体,纸质媒体,应用程序等,以及社交媒体网站,例如微博,微信和论坛.

网站,列管理

现在我们的采集大约涵盖6W网站,并且每天都在不断增加. 我们如何管理如此大量的网站?这就是源系统的价值!

我们在源系统中管理需要采集的网站以及需要采集的通道或列. 同时,某些网站媒体类别,行业类别,网站类型等都在系统中进行管理.

同时,为了提高网站和列的配置效率,我们支持将列的HTML源代码直接复制到系统中,然后自动分析列名,列URL,正则表达式列下的数据和其他数据. 通过这种优化,每个人每天配置大约20个网站,但现在已增加到100个以上.

关键字搜索

数据采集,除了直接发布信息采集的网站外,另一种快速获取数据的方法是在主要搜索引擎采集中搜索关键词,例如百度,搜狗,360和其他公司的搜索引擎.

在源系统中,除了上述两种类型的采集源外,它还可以管理服务器,部署的采集器等. 因为在大量采集中,有数百台服务器,而三,五台或每个服务器上甚至部署了十或二十个爬虫. 这些采集器的上载,部署,启动和关闭也既费时又耗能. 事情. 通过系统的统一管理,可以大大减少部署,运维和维护的时间,并可以降低很多成本.

第二: 建立网站监控系统

这部分主要包括两个部分: 一个是监视网站或列的状态(可以正常访问);另一个是对常规信息的监视;

网站,列的状态监控

1: 自动化

通常情况下,它是通过自动方式每两周或一个月检查一次所有网站.

然后返回状态码不是200,然后再次执行第二和第三次检查. 主要目的是防止由于网络问题或网站响应问题引起的监视失败,并增加人工二次处理的时间;

根据验证码,删除404、403和其他类型,以及502,一段时间后将再次检查未记录的域名和其他类型. 但是请记住同步关闭网站的这些采集,否则采集效率会大大降低.

2: 传递结果数据

如果您有10W网站,则每次执行自动验证都非常耗时. 为了提高效率,我们可以结合采集结果进行处理. 根据采集的结果数据,我们首先分析最近一周哪些列没有采集数据,然后自动验证这些网站,这将大大提高效率.

3: 爬行动物监控

当然,我们也可以在解析HTML源代码时标记采集器数据. 如果网站没有响应,则直接保存任务的ID,然后在源系统中进行标记,运维人员可以实时查看网站的状态并及时处理,以提高数据采集的效率.

同时,如果网站正常返回数据,但未解析任何信息,则该任务可能是常规异常,也可能是网站异常. 需要第二次测试.

正则表达式验证

如上所述,在采集中,我们可以通过当前列或网站记录是否根据现有的正则表达式对数据进行了解析,如果不是,则在徽标上将源系统中的相应列记录下来.

同时,有必要建立一种服务,该服务可自动识别列的正则表达式,每隔一段时间(例如30分钟)读取一次已识别的记录,自动识别正则表达式并进行同步到采集队列.

为了确保正则表达式的正确性,在自动识别并同步到采集队列后,如果仍然没有匹配信息. 此时,系统需要提示运维人员进行手工分析.

第三: 数据补充

在民意监测中,无论您涵盖的采集范围如何,总是会有一些数据. 您没有采集,但是可以看到. 这时,我要求改善客户体验,我们需要密切注意手动补充记录到系统中,然后?

然后,我们首先需要分析我们的网站是否已配置,列是否已正确配置以及正则表达式是否正确. 通过对这些步骤的检查,可以找到错过采矿的原因. 根据原因,优化源或完善采集器.

数据补充可以及时减少客户的不满意,同时可以改善源和采集,从而实现闭环采集.

第四: 自动化

首先: 智能识别采集频率

现在我们的网站和列采集的频率仍然是固定频率,因此一些信息更新相对较低或无效的列采集的网站将大大降低采集效率. 这会导致频繁的网站或列采集延迟,从而无法更新信息,从而降低了数据价值.

我们现在正在基于每个站点或带有采集数据的列的发布时间分布,统计分析更合适的采集频率,以最大程度地减少服务器资源的浪费并提高采集效率并最大化数据价值.

第二: 智能识别网站专栏

我们的采集网站约为6W,专栏约为70W. 这些6W网站,每天都有许多网站升级和修订,货架上有大量新柱子,旧柱子已经下架. 仅3人的运维团队就无法完成这些工作负载.

因此,我们根据6W网站中配置的列对它们进行训练,然后每周分析一次网站以自动识别列. 然后,筛选出与我的业务无关的列,最后进行手动抽样检查,最后将其发布到用于采集的采集队列. 这样,我们的运维团队已从9人减少到3人. 它还可以确保采集的稳定性和效率.

如今,当大数据流行时,所有分析的基础都是数据.

随着人工智能时代的到来,人类可以做的事几乎都可以由机器代替.

那么,在30至50年内,机器人能击败人类吗?哈哈...

案例研究:Web信息主题采集技术研究.pdf 7页

采集交流 • 优采云 发表了文章 • 0 个评论 • 414 次浏览 • 2020-08-30 19:07

Web信息主题采集技术研究李春旺(中国科学院文献信息中心,北京100080)[摘要]在对主题信息采集系统进行简要介绍之后,本文对其核心进行了深入研究. 5个方面的技术,包括种子页面生成,主题表示,相关性计算策略,爬网策略和结束搜索策略. 详细讨论了种子页生成的手动,自动和混合方法,基于关键字的主题表示和基于本体的主题表示,多种相关性计算启发式策略的比较,基本爬网策略和隧道技术以及许多最终爬网的情况和情况以此类推. 文章不仅分析了相关技术的算法,特点和应用,还根据主题信息采集的特点提出了相应的改进意见. [关键词]网络搜索引擎主题采集技术概述[分类号] G250.76; G252.7集中式Web爬虫技术李春旺(中国科学院图书馆北京100080)[摘要]本文简要介绍了集中式Web爬虫的核心技术. 三种主要模式用于创建种子URL. 本文讨论并分析了一些基于关键字和本体的主题描述,各种启发式功能和算法,隧道方法,基本的集中爬网策略和停止爬网策略等技术方法. 此外,通过比较焦点爬行算法的优缺点,提出了改进Web爬行技术的建议. [关键词]焦点在于Web搜索引擎的爬行技术随着网络技术和信息需求的发展,普通搜索引擎的缺点越来越多更明显.

它搜索整个Web,但是实际覆盖率不到所有静态网页的20%[1];它使用相同的信息域来支持来自所有用户的各种检索请求,缺乏针对性,从而导致大量不相关的结果. 为了克服通用搜索引擎的缺点并满足科研人员针对特定学科的深入信息需求,人们提出了基于主题的搜索技术. 所谓主题搜索是指根据用户自定义主题内容搜索有限的网络空间,发现和下载主题相关信息,并提供个性化信息服务. 主题信息采集系统代表了搜索引擎的未来发展方向[2],其核心技术包括种子页面生成,主题表示,相关性计算策略,主题爬网策略和最终搜索策略. 1种子页面生成技术种子页面是主题爬网的起始页面. 每个种子页面是一个特定的网页,可以是网站的主页或网站的子页面. 为了突出爬行起点的特殊性,缩小爬行范围并提高爬行效率,在这里将其称为“种子页面”而不是“种子站点”. 种子页面的选择将直接影响信息采集的质量和采集工作的效率. 因此,种子页面需要具有较高的主题相关性和主题链接的中心性. 生成种子页面的方法有三种: ①手动指定,即专家给出的相关种子页面,也称为模板页面; ②自动生成,用户指定一些关键字(例如: “数字图书馆”,“重点爬虫”),并将这些关键字提交给常规搜索引擎(例如Google),从搜索结果中提取前N页作为种子页面; ③混合模式,即自动生成和手动指定的组合,首先使用通用搜索引擎来获取一些相关页面. 然后手动筛选,过滤,合并和评估页面,以形成一组种子页面,这些页面可以完全反映主题的特征.

构造种子页面是一个复杂的过程,并且上述方法也有局限性. 最好的策略是增加系统的学习能力. 通过建立主题主题种子页面库,基于对搜索历史和用户反馈信息的分析,可以动态优化相关主题的种子页面集,并提供默认种子页面用于自定义新主题,并且为用户提供了种子页选择和评估的参考. 2主题表示技术主题描述的不正确通常是导致搜索结果不佳的重要原因. Soumen Chakrabarti等人的研究. [3-4]显示,要获得良好的搜索结果,搜索查询平均需要7.03个搜索词和4.34个运算符,而Alta Vista实际收到的用户搜索查询平均只收录2.35个关键字和0.41个运算符. 主题表示是主题信息采集的前提. 当前常用的主题表示形式包括关键字符号,本体表示法等. 2.1基于关键字的主题表示法基于关键字的主题表示法是指使用功能关键字集(主题关键字)来表示主题内容. 关键字可以是单个单词或短语,包括诸如权重和语言之类的属性. 关键字通常从种子文档中提取. 种子文档包括用户指定的模板文档(包括在爬网之前指定的相关文档和在爬网期间用户反馈的相关文档),与种子页面相对应的相关文档以及指向种子页面的邻居链接. 扩展后生成的文档.

所谓的邻居链扩展是指根据链接入和链接出关系扩展种子页面,并增加指向种子页面的父页面(取第一个N),从而扩展种子文档集. 该邻居链扩展可以根据需要重复多次. Goo gle和Alta Vista等搜索引擎提供父链查询服务. 例如,如果您向Google提交搜索查询: 链接: / home / kleinber /,则可以返回所有指向/ home / kleinber /页面的父页面. ARC测试系统[5]采用这种方法来建立种子文件. 生成主题headwords通常涉及以下7个步骤: 第一步是接收用户输入的模板文档(如果有);第二步是生成种子页面;第三步是通过邻居链扩展种子页面以生成扩展种子页面(重复该操作,直到满足指定条件为止);第四步,根据扩展后的种子页面获取对应的种子文档集;第五步,将用户输入的样本文档与系统生成的种子文档集合并为种子文档sDOC. 第六步,使用TF / IDF等算法计算种子文档sDOC的词频,并计算权重. 第七步,使用权重最高的前N个词形成关键字集,以表示给定爬行任务Q [6]的主题. 早期的主题采集系统基本上采用了基于关键词集的主题表示,例如Mercator [7]和北京大学天网.

2.2基于本体的主题表示技术使用概念集来描述用户需求. 它不仅可以很好地描述主题内容,而且可以揭示概念之间的语义关系,提高主题描述的准确性,并使主题的相关性计算和主题爬网策略计算更加准确. 为了创建主题本体,有必要首先根据对主题内容,主题范围和用户需求的相关条件的分析,确定相关的概念和属性;然后,根据主题本体系统,建立主题概念和属性之间的关系和功能,并生成主题本体的具体实例. 最后,利用主题本体指导主题信息采集中的主题判断2,并在采集过程中利用用户反馈不断优化主题本体实例,从而更好地表达主题信息. 相关匹配计算是基于本体主题实现的关键. 本体是有向图,目标文档是文本流. 由于结构上的差异,无法将两者直接关联,需要对其进行结构化. 通常有三种匹配方法: 第一种方法基于文本流的相关性匹配,即将主题本体的有向图转换为ASCII文本流,然后在文本流上进行两者之间的匹配计算被实现. 这种方法的优点是易于实现. 缺点是不可能用文本流来表达有向图的所有语义,从而降低了本体的原创语义表达优势.

第二种方法基于有向图的相关匹配. 原理是将目标文档转换为有向图,即使用自然语言理解工具分析文档的语法结构和语义内容,以建立类似本体论的文档内容图,以实现图形级的匹配计算. . 该方法的优点是充分发挥了本体论的优势,实现了语义层次上的关联性判断. 缺点是很难以图形方式记录文档[8]. 第三种方法是基于中间格式的相关匹配,即将有向图和文本流同时转换为第三方结构模式,并在通用结构模型的基础上实现相关匹配计算. . 关于基于本体的主题信息表示,德国卡尔斯鲁厄大学的马克·埃里格等人于2003年开发了一个实验系统CATYRPEL [9] [10],该系统包括用户交互界面,Web采集器,文档预处理器,本体管理五个部分. 处理器和相关性计算模块. 该研究在主题信息的本体表示和基于本体文档相关性的计算中提出了具体的实现模型,并提出了四种搜索策略: 简单搜索(相关性计算仅比较实体本身),分类词汇搜索(上位词和上位词的附加比较). 较低的实体),相关性搜索(增加实体之间的相关性比较),全属性搜索(上述方法的组合). 3关联计算策略关联计算是主题信息采集的核心技术. 它不仅直接影响主题采集的质量和效率,而且还影响结果信息的显示顺序. 因此,在计算网页的相关性并等待对URL爬网的优先级进行排序时,需要集成多种启发式策略.

3.1启发式策略假设L是从网页P到网页C的链接(请参见图1),已经下载并解析了网页P,网页C是要下载的页面,则基于L,P和爬网主题Q在估计网页C的潜在主题相关性时,可以考虑的启发式策略包括: ①P和Q页的相关性; ②链接L和Q的锚文本的相关性; ③链接L和Q的相关性的周围文本; ④链接L与Q的URL超链接字符串的相关性; ⑤链接L与Q的同级链接的相关性; ⑥L的上下文与其他已知相关网页的上下文等的相似性. L链接P网页C网页图片1网页P指向网页C 3.2关联算法3主题关联算法可基于文本分为两种内容分类和图结构分析. 作为一种经典的关联算法,基于文本内容分类的主要思想是词频统计. 它需要预先训练分类器以生成分类知识库,然后使用该知识库来识别目标文档的主题. 用于文本分类的常用模型是布尔模型. ,向量空间模型,概率模型,其中最常用的是向量空间模型. Web图形分析方法对超链接结构进行分析和计算,并对文档内容的相关性进行加权,以提高相关性计算的准确性. 当前,最具影响力的算法包括PageRank,HITS,ARC,CLEVER等.

(1)PageRank. PageRank根据页面的链接输入和链接输出值计算网页的重要性,Google使用此算法. 原创的PageRank算法将整个网络用作计算域,其计算结果与任何用户主题都不相关,并且适合发现权威的网页,但不适合发现主题资源. 对于主题信息采集,应相应地修改PageRank算法,并将计算域从原创的整个网络更改为与该主题相关的文档集合. Teoma [11]采用这种方法. 它从与爬虫采集到的主题相关的网页中形成一个相关的页面社区(社区),然后计算该区域中该网页的PageRank,以便计算出的结果可用于指导后续主题资源的采集更有效. (2)HITS(超链接诱导主题搜索). HITS通过权限级别和中心级别来区分网页的重要性,并通过对查询结果集执行相关计算来获取每个页面的HITS值. 尽管HITS还会根据查询结果集来计算网页的权限和中心性,但它仅基于前向链和后向链,并且不考虑文本内容,尤其是文本语义,因此使用HITS进行指导主题信息采集很容易导致对象污染(污染)或对象漂移(漂移). [12](3)ARC(自动资源编译).

P. Raghavan在斯坦福大学创建了一个实验系统ARC [5],它改进了HITS算法. 首先,ARC重新定义了网页的权限和中心性: 权限页(authority)指的是收录更多爬网主题的网页,而集线器页面(hub)指的是收录大量指向权威网页的链接的网页. 这些链接所指向的网页收录许多与主题相关的信息. 其次,ARC在估计要爬网的页面的相关性时开始考虑锚文本,后来人们将锚文本扩展到其上下文信息. (4)聪明[13]. 在主题信息搜索过程中,主题污染或漂移的主要原因来自页面(受欢迎)的重要性,而不是无关文档的重要性. 这些因素包括网站禁用,搜索词加权模式,链接加权模式以及相关的{mask2}之间的重复链接等. 为解决主题漂移问题,CLEVER改进了HITS算法. 在计算网页的权限和中心性时,它会保留相关的节点,并切断无关的节点;仅适用于一个网站或一位作者的多个超链接,保留其中一个具有最高权限,并删除其他超链接;在所有超链接中选择中心值最高的一个. 实验表明,CLEVER算法在防止话题漂移方面取得了良好的效果. 4主题爬网策略主题爬网策略是将主题搜索引擎与普通搜索引擎区分开的特征.

主题搜寻策略的目标是确保采集器获取尽可能多的与主题相关的信息,并下载尽可能少的与主题无关的信息,以提高发现率和覆盖范围. 主题信息. 在制定主题爬网策略时,应考虑各种因素,包括要爬网的URL选择策略,优先级排序策略,隧道技术和主题漂移响应策略. 4 4.1基本爬网策略通用搜索引擎一般采用广度优先的搜索策略,可以保证较高的覆盖率,但主题发现率不高. 主题搜索引擎采用主题优先级策略(最佳优先搜索),该策略根据主题相关性安排要爬网的所有URL,并首先对主题相关性最高的页面进行爬网,以确保采集器遵循主题相关性更高的路由[14]. 在主题采集器领域,该算法已成为评估相关技术的基准[15]. 但是,主题优先的爬网策略也有许多缺点. 针对这些缺点,已经提出了几种改进的算法. 4.1.1有限内存搜索(Limited Memory Search)[16]仅在要爬网的队列中保留具有最高相关性的前N个链接,并将第N + 1个及后续链接视为低相关或不相关页面. 此方法丢弃具有低相关性的URL,并减少系统占用的缓冲区空间. 同时,爬网范围仅限于高度相关的区域. 搜寻结果的主题非常相关. 缺点是它缺少通过低相关性页面进行的发现. 高度相关网页的机会.

4.1.2 BFSK搜索算法(波束搜索)[17]保留整个队列的爬网,但是一次从队列中删除前K个URL,并批量下载所有K页,确保同一页面区域以集中方式下载,避免了其他区域中的页面主题漂移所影响. [18] 4.1.3 Fish搜索算法(Fish-Search)Fish搜索算法的关键是根据用户的种子站点和查询关键字动态维护要爬网的URL的优先级队列. 优点是模式简单,可以实现动态搜索,但是因为它仅使用简单的字符串匹配来分配子节点的潜在相关性值,并且该值是离散的(0、0.5和1),从而导致分配值不能很好地表示子节点的相关性. 同时,要抓取的队列中的优先级差异太小,网页之间的优先级关系不明显. 南京大学的互联网数据采集系统[19]使用Fish算法. 4.1.4鲨鱼算法(Shark-Search)[20]. 响应于Fish算法中的二元判断,Shark算法引入了一种相关度量方法,其值在0到1之间,并且按比例将父节点的相关性转移到子节点;在计算子节点的潜在相关性时,应综合考虑指向子节点链接的锚文本,锚点周围的文本以及父节点的整个文本信息内容的相关性. 与Fish算法相比,Shark算法具有更高的准确度,可以更好地确保爬虫的正确搜索方向,提高相关信息的发现率.

4.2隧道技术如何通过低关联度区域并进入高关联度信息区域是主题爬网系统需要解决的重要问题. 酯[21]称其为隧道. 隧道技术的基本思想是: 当爬虫进入低相关性网页区域时,主题区域会扩展;当爬虫重新进入正常区域时,它将恢复为最初定义的主题区域. 具体的实现方法如下: ①主题词泛化,即当爬虫所在区域的页面主题相关性低于给定阈值时,采用主题词(或本体论)的上类别词. ,例如“微生物”,而不是原创的主题词“细菌”;当爬虫所在区域的页面相关性上升并且超过给定阈值时,将恢复最初指定的主题词,例如将“微生物”恢复为“细菌”. ②表达式概括. 对于形式为Φ= A question的问题表达式,将A∩Β的相关性f∩替换为A的相关性f(例如,AAΒ结果f 查看全部

网络信息主题采集技术研究.pdf 7页

Web信息主题采集技术研究李春旺(中国科学院文献信息中心,北京100080)[摘要]在对主题信息采集系统进行简要介绍之后,本文对其核心进行了深入研究. 5个方面的技术,包括种子页面生成,主题表示,相关性计算策略,爬网策略和结束搜索策略. 详细讨论了种子页生成的手动,自动和混合方法,基于关键字的主题表示和基于本体的主题表示,多种相关性计算启发式策略的比较,基本爬网策略和隧道技术以及许多最终爬网的情况和情况以此类推. 文章不仅分析了相关技术的算法,特点和应用,还根据主题信息采集的特点提出了相应的改进意见. [关键词]网络搜索引擎主题采集技术概述[分类号] G250.76; G252.7集中式Web爬虫技术李春旺(中国科学院图书馆北京100080)[摘要]本文简要介绍了集中式Web爬虫的核心技术. 三种主要模式用于创建种子URL. 本文讨论并分析了一些基于关键字和本体的主题描述,各种启发式功能和算法,隧道方法,基本的集中爬网策略和停止爬网策略等技术方法. 此外,通过比较焦点爬行算法的优缺点,提出了改进Web爬行技术的建议. [关键词]焦点在于Web搜索引擎的爬行技术随着网络技术和信息需求的发展,普通搜索引擎的缺点越来越多更明显.

它搜索整个Web,但是实际覆盖率不到所有静态网页的20%[1];它使用相同的信息域来支持来自所有用户的各种检索请求,缺乏针对性,从而导致大量不相关的结果. 为了克服通用搜索引擎的缺点并满足科研人员针对特定学科的深入信息需求,人们提出了基于主题的搜索技术. 所谓主题搜索是指根据用户自定义主题内容搜索有限的网络空间,发现和下载主题相关信息,并提供个性化信息服务. 主题信息采集系统代表了搜索引擎的未来发展方向[2],其核心技术包括种子页面生成,主题表示,相关性计算策略,主题爬网策略和最终搜索策略. 1种子页面生成技术种子页面是主题爬网的起始页面. 每个种子页面是一个特定的网页,可以是网站的主页或网站的子页面. 为了突出爬行起点的特殊性,缩小爬行范围并提高爬行效率,在这里将其称为“种子页面”而不是“种子站点”. 种子页面的选择将直接影响信息采集的质量和采集工作的效率. 因此,种子页面需要具有较高的主题相关性和主题链接的中心性. 生成种子页面的方法有三种: ①手动指定,即专家给出的相关种子页面,也称为模板页面; ②自动生成,用户指定一些关键字(例如: “数字图书馆”,“重点爬虫”),并将这些关键字提交给常规搜索引擎(例如Google),从搜索结果中提取前N页作为种子页面; ③混合模式,即自动生成和手动指定的组合,首先使用通用搜索引擎来获取一些相关页面. 然后手动筛选,过滤,合并和评估页面,以形成一组种子页面,这些页面可以完全反映主题的特征.

构造种子页面是一个复杂的过程,并且上述方法也有局限性. 最好的策略是增加系统的学习能力. 通过建立主题主题种子页面库,基于对搜索历史和用户反馈信息的分析,可以动态优化相关主题的种子页面集,并提供默认种子页面用于自定义新主题,并且为用户提供了种子页选择和评估的参考. 2主题表示技术主题描述的不正确通常是导致搜索结果不佳的重要原因. Soumen Chakrabarti等人的研究. [3-4]显示,要获得良好的搜索结果,搜索查询平均需要7.03个搜索词和4.34个运算符,而Alta Vista实际收到的用户搜索查询平均只收录2.35个关键字和0.41个运算符. 主题表示是主题信息采集的前提. 当前常用的主题表示形式包括关键字符号,本体表示法等. 2.1基于关键字的主题表示法基于关键字的主题表示法是指使用功能关键字集(主题关键字)来表示主题内容. 关键字可以是单个单词或短语,包括诸如权重和语言之类的属性. 关键字通常从种子文档中提取. 种子文档包括用户指定的模板文档(包括在爬网之前指定的相关文档和在爬网期间用户反馈的相关文档),与种子页面相对应的相关文档以及指向种子页面的邻居链接. 扩展后生成的文档.

所谓的邻居链扩展是指根据链接入和链接出关系扩展种子页面,并增加指向种子页面的父页面(取第一个N),从而扩展种子文档集. 该邻居链扩展可以根据需要重复多次. Goo gle和Alta Vista等搜索引擎提供父链查询服务. 例如,如果您向Google提交搜索查询: 链接: / home / kleinber /,则可以返回所有指向/ home / kleinber /页面的父页面. ARC测试系统[5]采用这种方法来建立种子文件. 生成主题headwords通常涉及以下7个步骤: 第一步是接收用户输入的模板文档(如果有);第二步是生成种子页面;第三步是通过邻居链扩展种子页面以生成扩展种子页面(重复该操作,直到满足指定条件为止);第四步,根据扩展后的种子页面获取对应的种子文档集;第五步,将用户输入的样本文档与系统生成的种子文档集合并为种子文档sDOC. 第六步,使用TF / IDF等算法计算种子文档sDOC的词频,并计算权重. 第七步,使用权重最高的前N个词形成关键字集,以表示给定爬行任务Q [6]的主题. 早期的主题采集系统基本上采用了基于关键词集的主题表示,例如Mercator [7]和北京大学天网.

2.2基于本体的主题表示技术使用概念集来描述用户需求. 它不仅可以很好地描述主题内容,而且可以揭示概念之间的语义关系,提高主题描述的准确性,并使主题的相关性计算和主题爬网策略计算更加准确. 为了创建主题本体,有必要首先根据对主题内容,主题范围和用户需求的相关条件的分析,确定相关的概念和属性;然后,根据主题本体系统,建立主题概念和属性之间的关系和功能,并生成主题本体的具体实例. 最后,利用主题本体指导主题信息采集中的主题判断2,并在采集过程中利用用户反馈不断优化主题本体实例,从而更好地表达主题信息. 相关匹配计算是基于本体主题实现的关键. 本体是有向图,目标文档是文本流. 由于结构上的差异,无法将两者直接关联,需要对其进行结构化. 通常有三种匹配方法: 第一种方法基于文本流的相关性匹配,即将主题本体的有向图转换为ASCII文本流,然后在文本流上进行两者之间的匹配计算被实现. 这种方法的优点是易于实现. 缺点是不可能用文本流来表达有向图的所有语义,从而降低了本体的原创语义表达优势.

第二种方法基于有向图的相关匹配. 原理是将目标文档转换为有向图,即使用自然语言理解工具分析文档的语法结构和语义内容,以建立类似本体论的文档内容图,以实现图形级的匹配计算. . 该方法的优点是充分发挥了本体论的优势,实现了语义层次上的关联性判断. 缺点是很难以图形方式记录文档[8]. 第三种方法是基于中间格式的相关匹配,即将有向图和文本流同时转换为第三方结构模式,并在通用结构模型的基础上实现相关匹配计算. . 关于基于本体的主题信息表示,德国卡尔斯鲁厄大学的马克·埃里格等人于2003年开发了一个实验系统CATYRPEL [9] [10],该系统包括用户交互界面,Web采集器,文档预处理器,本体管理五个部分. 处理器和相关性计算模块. 该研究在主题信息的本体表示和基于本体文档相关性的计算中提出了具体的实现模型,并提出了四种搜索策略: 简单搜索(相关性计算仅比较实体本身),分类词汇搜索(上位词和上位词的附加比较). 较低的实体),相关性搜索(增加实体之间的相关性比较),全属性搜索(上述方法的组合). 3关联计算策略关联计算是主题信息采集的核心技术. 它不仅直接影响主题采集的质量和效率,而且还影响结果信息的显示顺序. 因此,在计算网页的相关性并等待对URL爬网的优先级进行排序时,需要集成多种启发式策略.

3.1启发式策略假设L是从网页P到网页C的链接(请参见图1),已经下载并解析了网页P,网页C是要下载的页面,则基于L,P和爬网主题Q在估计网页C的潜在主题相关性时,可以考虑的启发式策略包括: ①P和Q页的相关性; ②链接L和Q的锚文本的相关性; ③链接L和Q的相关性的周围文本; ④链接L与Q的URL超链接字符串的相关性; ⑤链接L与Q的同级链接的相关性; ⑥L的上下文与其他已知相关网页的上下文等的相似性. L链接P网页C网页图片1网页P指向网页C 3.2关联算法3主题关联算法可基于文本分为两种内容分类和图结构分析. 作为一种经典的关联算法,基于文本内容分类的主要思想是词频统计. 它需要预先训练分类器以生成分类知识库,然后使用该知识库来识别目标文档的主题. 用于文本分类的常用模型是布尔模型. ,向量空间模型,概率模型,其中最常用的是向量空间模型. Web图形分析方法对超链接结构进行分析和计算,并对文档内容的相关性进行加权,以提高相关性计算的准确性. 当前,最具影响力的算法包括PageRank,HITS,ARC,CLEVER等.

(1)PageRank. PageRank根据页面的链接输入和链接输出值计算网页的重要性,Google使用此算法. 原创的PageRank算法将整个网络用作计算域,其计算结果与任何用户主题都不相关,并且适合发现权威的网页,但不适合发现主题资源. 对于主题信息采集,应相应地修改PageRank算法,并将计算域从原创的整个网络更改为与该主题相关的文档集合. Teoma [11]采用这种方法. 它从与爬虫采集到的主题相关的网页中形成一个相关的页面社区(社区),然后计算该区域中该网页的PageRank,以便计算出的结果可用于指导后续主题资源的采集更有效. (2)HITS(超链接诱导主题搜索). HITS通过权限级别和中心级别来区分网页的重要性,并通过对查询结果集执行相关计算来获取每个页面的HITS值. 尽管HITS还会根据查询结果集来计算网页的权限和中心性,但它仅基于前向链和后向链,并且不考虑文本内容,尤其是文本语义,因此使用HITS进行指导主题信息采集很容易导致对象污染(污染)或对象漂移(漂移). [12](3)ARC(自动资源编译).

P. Raghavan在斯坦福大学创建了一个实验系统ARC [5],它改进了HITS算法. 首先,ARC重新定义了网页的权限和中心性: 权限页(authority)指的是收录更多爬网主题的网页,而集线器页面(hub)指的是收录大量指向权威网页的链接的网页. 这些链接所指向的网页收录许多与主题相关的信息. 其次,ARC在估计要爬网的页面的相关性时开始考虑锚文本,后来人们将锚文本扩展到其上下文信息. (4)聪明[13]. 在主题信息搜索过程中,主题污染或漂移的主要原因来自页面(受欢迎)的重要性,而不是无关文档的重要性. 这些因素包括网站禁用,搜索词加权模式,链接加权模式以及相关的{mask2}之间的重复链接等. 为解决主题漂移问题,CLEVER改进了HITS算法. 在计算网页的权限和中心性时,它会保留相关的节点,并切断无关的节点;仅适用于一个网站或一位作者的多个超链接,保留其中一个具有最高权限,并删除其他超链接;在所有超链接中选择中心值最高的一个. 实验表明,CLEVER算法在防止话题漂移方面取得了良好的效果. 4主题爬网策略主题爬网策略是将主题搜索引擎与普通搜索引擎区分开的特征.

主题搜寻策略的目标是确保采集器获取尽可能多的与主题相关的信息,并下载尽可能少的与主题无关的信息,以提高发现率和覆盖范围. 主题信息. 在制定主题爬网策略时,应考虑各种因素,包括要爬网的URL选择策略,优先级排序策略,隧道技术和主题漂移响应策略. 4 4.1基本爬网策略通用搜索引擎一般采用广度优先的搜索策略,可以保证较高的覆盖率,但主题发现率不高. 主题搜索引擎采用主题优先级策略(最佳优先搜索),该策略根据主题相关性安排要爬网的所有URL,并首先对主题相关性最高的页面进行爬网,以确保采集器遵循主题相关性更高的路由[14]. 在主题采集器领域,该算法已成为评估相关技术的基准[15]. 但是,主题优先的爬网策略也有许多缺点. 针对这些缺点,已经提出了几种改进的算法. 4.1.1有限内存搜索(Limited Memory Search)[16]仅在要爬网的队列中保留具有最高相关性的前N个链接,并将第N + 1个及后续链接视为低相关或不相关页面. 此方法丢弃具有低相关性的URL,并减少系统占用的缓冲区空间. 同时,爬网范围仅限于高度相关的区域. 搜寻结果的主题非常相关. 缺点是它缺少通过低相关性页面进行的发现. 高度相关网页的机会.

4.1.2 BFSK搜索算法(波束搜索)[17]保留整个队列的爬网,但是一次从队列中删除前K个URL,并批量下载所有K页,确保同一页面区域以集中方式下载,避免了其他区域中的页面主题漂移所影响. [18] 4.1.3 Fish搜索算法(Fish-Search)Fish搜索算法的关键是根据用户的种子站点和查询关键字动态维护要爬网的URL的优先级队列. 优点是模式简单,可以实现动态搜索,但是因为它仅使用简单的字符串匹配来分配子节点的潜在相关性值,并且该值是离散的(0、0.5和1),从而导致分配值不能很好地表示子节点的相关性. 同时,要抓取的队列中的优先级差异太小,网页之间的优先级关系不明显. 南京大学的互联网数据采集系统[19]使用Fish算法. 4.1.4鲨鱼算法(Shark-Search)[20]. 响应于Fish算法中的二元判断,Shark算法引入了一种相关度量方法,其值在0到1之间,并且按比例将父节点的相关性转移到子节点;在计算子节点的潜在相关性时,应综合考虑指向子节点链接的锚文本,锚点周围的文本以及父节点的整个文本信息内容的相关性. 与Fish算法相比,Shark算法具有更高的准确度,可以更好地确保爬虫的正确搜索方向,提高相关信息的发现率.

4.2隧道技术如何通过低关联度区域并进入高关联度信息区域是主题爬网系统需要解决的重要问题. 酯[21]称其为隧道. 隧道技术的基本思想是: 当爬虫进入低相关性网页区域时,主题区域会扩展;当爬虫重新进入正常区域时,它将恢复为最初定义的主题区域. 具体的实现方法如下: ①主题词泛化,即当爬虫所在区域的页面主题相关性低于给定阈值时,采用主题词(或本体论)的上类别词. ,例如“微生物”,而不是原创的主题词“细菌”;当爬虫所在区域的页面相关性上升并且超过给定阈值时,将恢复最初指定的主题词,例如将“微生物”恢复为“细菌”. ②表达式概括. 对于形式为Φ= A question的问题表达式,将A∩Β的相关性f∩替换为A的相关性f(例如,AAΒ结果f

舆情大作战之教你用爬虫实时监控凤凰网新闻信息数据

采集交流 • 优采云 发表了文章 • 0 个评论 • 195 次浏览 • 2020-08-30 17:23

功能点目录:

如何配置采集字段

如何获取列表+详细页面类型的网页

采集结果预览:

让我们详细介绍如何采集Phoenix.com的新闻数据. 让我们以Phoenix.com的技术频道下的互联网新闻为例. 具体步骤如下:

步骤1: 下载并安装优采云采集器,然后注册并登录

1. 打开优采云采集器的官方网站,下载并安装最新版本的优采云采集器

2. 单击注册以登录,注册新帐户,登录优采云采集器

[提醒]您无需注册即可直接使用该采集器软件,但是切换到注册用户时,匿名帐户下的任务将会丢失,因此建议您在注册后使用它.

优采云采集器是优采云的产品,优采云用户可以直接登录.

第2步: 创建采集任务

1. 复制Phoenix.com的Internet新闻页面的URL(需要搜索结果页面的URL,而不是首页的URL)

2. 创建一个新的智能模式采集任务

您可以直接在软件上创建采集任务,也可以通过导入规则来创建任务.

第3步: 配置采集规则

1. 设置提取数据字段

在智能模式下,输入URL后,软件可以自动识别页面上的数据并生成采集结果. 每种数据类型都对应一个采集字段. 我们可以右键单击该字段以进行相关设置,包括“修改字段名称”,“增加或减少字段”,“过程数据”等.

在列表页面上,我们需要采集新闻标题,新闻链接和Phoenix News的发布时间. 字段设置效果如下:

2. 使用深度采集功能提取详细信息页面数据

在列表页面上,仅显示Phoenix.com的部分新闻. 如果您需要详细的新闻内容,我们需要右键单击新闻链接,然后使用“深度采集”功能跳转到{mask1}的详细信息页面.

在详细信息页面上,我们可以看到新闻的内容,来源,参加人数和评论,我们可以单击“添加字段”添加采集字段,字段设置的效果如下:

第4步: 设置并启动采集任务

1,设置采集任务

添加采集数据后,我们可以启动采集任务. 开始之前,我们需要对采集任务进行一些设置,以提高采集的稳定性和成功率.

单击“设置”按钮,然后在弹出的运行设置页面中设置运行设置和防阻塞设置. 这里我们选中“跳过继续采集”,设置为“ 2”秒请求等待时间,然后选中“不加载网页图片”,防阻塞设置将遵循系统默认设置,然后单击“保存”.

2,开始采集任务

单击“保存并开始”按钮,在弹出页面中进行一些高级设置,包括定时开始,自动存储和下载图片. 在此示例中未使用这些功能,只需单击“开始”以运行采集器工具.

[温馨提示]免费版可以使用非定期定时器拍摄功能,并且图片下载功能是免费的. 个人专业版及更高版本可以使用高级计时功能和自动存储功能.

3. 运行任务以提取数据

任务启动后,它将自动采集数据. 我们可以从界面直观地看到程序的运行过程和采集结果. 采集结束后会有提醒.

第5步: 导出和查看数据

数据采集完成后,我们可以查看和导出数据. 优采云采集器支持多种导出方法(手动导出到本地,手动导出到数据库,自动发布到数据库,自动发布到网站)以及导出文件的格式(EXCEL,CSV,HTML和TXT),我们选择方法和文件类型,然后单击“确认导出”.

[提醒]: 所有手动导出功能都是免费的. 个人专业版及更高版本可以使用“发布到网站”功能. 查看全部

教您使用采集器实时监视Phoenix.com的新闻信息数据.

功能点目录:

如何配置采集字段

如何获取列表+详细页面类型的网页

采集结果预览:

让我们详细介绍如何采集Phoenix.com的新闻数据. 让我们以Phoenix.com的技术频道下的互联网新闻为例. 具体步骤如下:

步骤1: 下载并安装优采云采集器,然后注册并登录

1. 打开优采云采集器的官方网站,下载并安装最新版本的优采云采集器

2. 单击注册以登录,注册新帐户,登录优采云采集器

[提醒]您无需注册即可直接使用该采集器软件,但是切换到注册用户时,匿名帐户下的任务将会丢失,因此建议您在注册后使用它.

优采云采集器是优采云的产品,优采云用户可以直接登录.

第2步: 创建采集任务

1. 复制Phoenix.com的Internet新闻页面的URL(需要搜索结果页面的URL,而不是首页的URL)

2. 创建一个新的智能模式采集任务

您可以直接在软件上创建采集任务,也可以通过导入规则来创建任务.

第3步: 配置采集规则

1. 设置提取数据字段

在智能模式下,输入URL后,软件可以自动识别页面上的数据并生成采集结果. 每种数据类型都对应一个采集字段. 我们可以右键单击该字段以进行相关设置,包括“修改字段名称”,“增加或减少字段”,“过程数据”等.

在列表页面上,我们需要采集新闻标题,新闻链接和Phoenix News的发布时间. 字段设置效果如下:

2. 使用深度采集功能提取详细信息页面数据

在列表页面上,仅显示Phoenix.com的部分新闻. 如果您需要详细的新闻内容,我们需要右键单击新闻链接,然后使用“深度采集”功能跳转到{mask1}的详细信息页面.

在详细信息页面上,我们可以看到新闻的内容,来源,参加人数和评论,我们可以单击“添加字段”添加采集字段,字段设置的效果如下:

第4步: 设置并启动采集任务

1,设置采集任务

添加采集数据后,我们可以启动采集任务. 开始之前,我们需要对采集任务进行一些设置,以提高采集的稳定性和成功率.

单击“设置”按钮,然后在弹出的运行设置页面中设置运行设置和防阻塞设置. 这里我们选中“跳过继续采集”,设置为“ 2”秒请求等待时间,然后选中“不加载网页图片”,防阻塞设置将遵循系统默认设置,然后单击“保存”.

2,开始采集任务

单击“保存并开始”按钮,在弹出页面中进行一些高级设置,包括定时开始,自动存储和下载图片. 在此示例中未使用这些功能,只需单击“开始”以运行采集器工具.

[温馨提示]免费版可以使用非定期定时器拍摄功能,并且图片下载功能是免费的. 个人专业版及更高版本可以使用高级计时功能和自动存储功能.

3. 运行任务以提取数据

任务启动后,它将自动采集数据. 我们可以从界面直观地看到程序的运行过程和采集结果. 采集结束后会有提醒.

第5步: 导出和查看数据

数据采集完成后,我们可以查看和导出数据. 优采云采集器支持多种导出方法(手动导出到本地,手动导出到数据库,自动发布到数据库,自动发布到网站)以及导出文件的格式(EXCEL,CSV,HTML和TXT),我们选择方法和文件类型,然后单击“确认导出”.

[提醒]: 所有手动导出功能都是免费的. 个人专业版及更高版本可以使用“发布到网站”功能.

一种自动化采集网页数据的系统及方式技术方案

采集交流 • 优采云 发表了文章 • 0 个评论 • 316 次浏览 • 2020-08-30 08:46

本发明专利技术提供一种自动化采集网页数据的系统及方式,该系统包括嵌入式浏览器、API接口、脚本引擎模块和流程控制模块,结合脚本引擎模块和流程控制模块共同实现对指定网页的访问和指定数据采集。脚本引擎模块促使本发明专利技术的自动化采集网页数据的系统具有在当前页面的内存地址中执行自定义的JS函数的能力,在网页加载完成后就能获取当前页面的内存地址,并借助JS脚本模拟用户的各类点击操作,流程控制模块可以定做具体页面上的采集内容,适用于对具体网页的数据进行精确处理或则是针对具体网页进行特殊处理,特别是对于税务网站的数据才能进行精确采集;可以实现采集流程自定义、采集内容自定义。

A system and method of collecting web data automatically

The invention provides a system and method for automatically collecting web page data, which comprises an embedded browser, an API interface, a script engine module and a process control module. The script engine module enables the system of automatic 采集 of web page data of the invention to execute the customized JS function in the memory address of the current page. After the web page is loaded, the memory address of the current page can be obtained, and the JS script is used to simulate various click operations of the user. The process control module can customize the 采集 content on the specific page, which is applicable to the specific page The data of the web page can be accurately processed or specially processed for the specific web page, especially for the data of the tax website; the 采集 process can be customized and the 采集 content can be customized.

全部详尽技术资料下载

【技术实现步骤摘要】

一种自动化采集网页数据的系统及技巧

本专利技术涉及网站数据采集

,尤其涉及一种自动化采集网页数据的系统及技巧。

技术介绍

目前互联网上抓取网页数据的方法主要是通过一种调度程序(爬虫)在互联网上下载网页,并录入数据库中,根据特定估算方法对数据库的信息进行采集、汇总、归类,其估算方法分为深度优先和广度优先形式。应用这种抓取网页数据的形式的如百度的蜘蛛爬虫,此类抓取网页数据的方法可以手动大批量的从网页中获取数据。但是,由于爬虫的数据爬取策略具有普适性,无法针对具体网页的数据进行精确处理、或者是针对具体网页进行特殊处理,特别是对于税务网站的数据难以进行精确采集。

技术实现思路

本专利技术的目的是为了解决现有技术中存在的缺点,而提出的一种自动化采集网页数据的系统及技巧。为实现上述目的,本专利技术采用了如下技术方案:一种自动化采集网页数据的系统,包括嵌入式浏览器、API接口、脚本引擎模块和流程控制模块,所述API插口与所述脚本引擎模块、所述流程控制模块分别嵌入所述嵌入式浏览器中。嵌入式浏览器采用IE内核或Chrome内核,或其他浏览器内核。优选地,所述脚本引擎模块用于加载JS脚本;所述JS脚本收录操作网页的自定义JS函数,当网页数据加载到计算机显存中后,所述JS脚本加载到所述脚本引擎模块中,用来在当前页面的内存地址中执行所述自定义JS函数,支撑网页数据采集过程。优选地,所述流程控制模块用于承载并执行批处理的命令,执行预配置的数据采集流程;优选地,所述批处理的命令为查询按键的点击、页面的跳转或则是网页数据的采集。优选地,所述脚本引擎模块和所述流程控制模块结合上去还用于在登入限制的网页页面模拟用户输入用户名和密码,模拟用户点击行为,通过登入验证。(具体怎么实现)根据本专利技术的另一面,还提供一种自动化采集网页数据的方式,包括以下步骤:步骤S10:平台数据库下发指定数据采集请求;步骤S20:登录待采集网站:嵌入式浏览器接收指定数据采集请求并访问指定的待采集网站,访问成功后接收到页面加载风波,同时获取页面加载完成后的内存地址;步骤S30:加载JS脚本:脚本引擎模块为当前页面加载JS脚本,在当前页面的内存地址中执行自定义JS函数;步骤S40:执行预配置的数据采集流程:流程控制模块按照预配置的流程执行批处理命令,按照批处理的执行流程逐渐执行,到预配置的页面采集指定数据;步骤S50:上传采集结果:将采集到的指定数据通过网路上传至所述平台数据库。

优选地,所述步骤S20中,当指定的待采集网站有登录限制时,所述脚本引擎模块和所述流程控制模块模拟用户输入用户名和密码,模拟用户点击行为,通过登入验证。与现有技术相比,本专利技术的有益疗效为:(1)在嵌入式浏览器基础上降低了脚本引擎模块和流程控制模块,结合上述两个模块共同实现对指定网页的自动化访问和采集,通过流程控制模块可以定做具体页面上的采集内容,适用于对具体网页的数据进行精确处理或则是针对具体网页进行特殊处理,特别是对于税务网站的数据才能进行精确采集;可以实现采集流程自定义、采集内容自定义;(2)针对存在登入限制的网页页面,利用脚本引擎模块和流程控制模块可以模拟用户输入用户名和密码,模拟用户点击行为,通过登入验证,进行自动化数据采集。附图说明图1为本专利技术施行例1的一种自动化采集网页数据的系统的结构图;图2为本专利技术施行例1的一种自动化采集网页数据的方式的流程图。其中,1-嵌入式浏览器,2-API接口,3-脚本引擎模块,4-流程控制模块。具体施行方法为让对本专利技术的目的、构造、特征、及其功能有进一步的了解,兹配合施行例详尽说明如下。实施例1:请参见图1,图1为本专利技术施行例1的一种自动化采集网页数据的系统的结构图,本专利技术施行例1的一种自动化采集网页数据的系统,包括嵌入式浏览器1、API接口2、脚本引擎模块3和流程控制模块4,API接口2与脚本引擎模块3、流程控制模块4分别嵌入嵌入式浏览器1。

本专利技术的自动化采集网页数据的系统结合脚本引擎模块3和流程控制模块4共同实现对指定网页的访问和指定数据采集。优选地,脚本引擎模块3用于加载JS脚本;JS脚本收录操作网页的自定义JS函数,对网页的执行动作须要JS脚本解释执行;当网页数据加载到计算机显存中后,JS脚本加载到脚本引擎模块3中,用来在当前页面的内存地址中执行自定义JS函数,支撑网页数据采集过程。脚本引擎模块3促使本专利技术的自动化采集网页数据的系统具有在当前页面的内存地址中执行自定义的JS函数的能力,脚本引擎模块3在网页加载完成后就能获取当前页面的内存地址,并借助JS脚本模拟用户的各类点击操作,采集dom元素(即Web页面上的对象及元素)上的内容。优选地,流程控制模块4用于承载并执行批处理的命令,执行预配置的数据采集流程;其中,批处理的命令为查询按键的点击、页面的跳转或则是网页数据的采集,每一条命令可能是一次查询按键的点击,或者一次页面的跳转,或者是网页数据的采集。传统的自动化采集系统只是按照固定的采集算法去批量采集页面数据,但是未能针对不同的页面进行不同的特殊处理,本专利技术的流程控制模块4支持流程自定义控制,支持任意订制采集内容,具有较强的灵活性,特别是在精确采集税务网站数据方面具有无可比拟的优势。

传统的自动化采集系统未能采集存在登入限制的网页页面的数据,具有较大的局限性。本专利技术的脚本引擎模块3和流程控制模块4结合上去还用于在登入限制的网页页面模拟用户输入用户名和密码,模拟用户点击行为,通过登陆验证。实施例2:根据本专利技术的另一面,还提供一种自动化采集网页数据的方式,请参见图2,图2为本专利技术施行例1的一种自动化采集网页数据的方式的流程图,本专利技术施行例1的一种自动化采集网页数据的方式包括以下步骤:步骤S10:平台数据库下发指定数据采集请求;步骤S20:登录待采集网站:嵌入式浏览器1接收指定数据采集请求并访问指定的待采集网站,访问成功后接收到页面加载风波,同时获取页面加载完成后的内存地址;步骤S30:加载JS脚本:脚本引擎模块3为当前页面加载JS脚本,在当前页面的内存地址中执行自定义JS函数;步骤S40:执行预配置的数据采集流程:流程控制模块4按照预配置的流程执行批处理命令,按照批处理的执行流程逐渐执行,到预配置的页面采集指定数据;步骤S50:上传采集结果:将采集到的指定数据通过网路上传至平台数据库。优选地,步骤S20中,当指定的待采集网站有登录限制时,脚本引擎模块3和流程控制模块4模拟用户输入用户名和密码,模拟用户点击行为,通过登陆验证。实施例3:本专利技术的自动化采集网页数据的系统及技巧应用场景广泛,例如可以应用于采集税务网站的网页数据,为顾客提供智能财税服务,利用顾客提供的帐号信息登陆税局网站,采集相关的财税数据信息,获取顾客在税务网站上的基本信息和财务信息,为智能财税服务提供数据支撑,为顾客

【技术保护点】

1.一种自动化采集网页数据的系统,其特点在于:包括嵌入式浏览器、API接口、脚本引擎模块和流程控制模块,所述API插口与所述脚本引擎模块、所述流程控制模块嵌入所述嵌入式浏览器中。/n

【技术特点摘要】

1.一种自动化采集网页数据的系统,其特点在于:包括嵌入式浏览器、API接口、脚本引擎模块和流程控制模块,所述API插口与所述脚本引擎模块、所述流程控制模块嵌入所述嵌入式浏览器中。

2.如权力要求1所述的自动化采集网页数据的系统,其特点在于:所述脚本引擎模块用于加载JS脚本;所述JS脚本收录操作网页的自定义JS函数,当网页数据加载到计算机显存中后,所述JS脚本加载到所述脚本引擎模块中,用来在当前页面的内存地址中执行所述自定义JS函数,支撑网页数据采集过程。

3.如权力要求1所述的自动化采集网页数据的系统,其特点在于:所述流程控制模块用于承载并执行批处理的命令,执行预配置的数据采集流程。

4.如权力要求3所述的自动化采集网页数据的系统,其特点在于:所述批处理的命令为查询按键的点击、页面的跳转或则是网页数据的采集。

5.如权力要求1所述的自动化采集网页数据的系统,其特点在于:所述脚本引擎模块和所述流程控制模块结合上去还用于在登入限制...

【专利技术属性】

技术研制人员:李沁,李娜,

申请(专利权)人:南京云帐房网络科技有限公司,

类型:发明

国别省市:江苏;32

全部详尽技术资料下载 我是这个专利的主人 查看全部

一种自动化采集网页数据的系统及方式技术方案

本发明专利技术提供一种自动化采集网页数据的系统及方式,该系统包括嵌入式浏览器、API接口、脚本引擎模块和流程控制模块,结合脚本引擎模块和流程控制模块共同实现对指定网页的访问和指定数据采集。脚本引擎模块促使本发明专利技术的自动化采集网页数据的系统具有在当前页面的内存地址中执行自定义的JS函数的能力,在网页加载完成后就能获取当前页面的内存地址,并借助JS脚本模拟用户的各类点击操作,流程控制模块可以定做具体页面上的采集内容,适用于对具体网页的数据进行精确处理或则是针对具体网页进行特殊处理,特别是对于税务网站的数据才能进行精确采集;可以实现采集流程自定义、采集内容自定义。

A system and method of collecting web data automatically

The invention provides a system and method for automatically collecting web page data, which comprises an embedded browser, an API interface, a script engine module and a process control module. The script engine module enables the system of automatic 采集 of web page data of the invention to execute the customized JS function in the memory address of the current page. After the web page is loaded, the memory address of the current page can be obtained, and the JS script is used to simulate various click operations of the user. The process control module can customize the 采集 content on the specific page, which is applicable to the specific page The data of the web page can be accurately processed or specially processed for the specific web page, especially for the data of the tax website; the 采集 process can be customized and the 采集 content can be customized.

全部详尽技术资料下载

【技术实现步骤摘要】

一种自动化采集网页数据的系统及技巧

本专利技术涉及网站数据采集

,尤其涉及一种自动化采集网页数据的系统及技巧。

技术介绍

目前互联网上抓取网页数据的方法主要是通过一种调度程序(爬虫)在互联网上下载网页,并录入数据库中,根据特定估算方法对数据库的信息进行采集、汇总、归类,其估算方法分为深度优先和广度优先形式。应用这种抓取网页数据的形式的如百度的蜘蛛爬虫,此类抓取网页数据的方法可以手动大批量的从网页中获取数据。但是,由于爬虫的数据爬取策略具有普适性,无法针对具体网页的数据进行精确处理、或者是针对具体网页进行特殊处理,特别是对于税务网站的数据难以进行精确采集。

技术实现思路

本专利技术的目的是为了解决现有技术中存在的缺点,而提出的一种自动化采集网页数据的系统及技巧。为实现上述目的,本专利技术采用了如下技术方案:一种自动化采集网页数据的系统,包括嵌入式浏览器、API接口、脚本引擎模块和流程控制模块,所述API插口与所述脚本引擎模块、所述流程控制模块分别嵌入所述嵌入式浏览器中。嵌入式浏览器采用IE内核或Chrome内核,或其他浏览器内核。优选地,所述脚本引擎模块用于加载JS脚本;所述JS脚本收录操作网页的自定义JS函数,当网页数据加载到计算机显存中后,所述JS脚本加载到所述脚本引擎模块中,用来在当前页面的内存地址中执行所述自定义JS函数,支撑网页数据采集过程。优选地,所述流程控制模块用于承载并执行批处理的命令,执行预配置的数据采集流程;优选地,所述批处理的命令为查询按键的点击、页面的跳转或则是网页数据的采集。优选地,所述脚本引擎模块和所述流程控制模块结合上去还用于在登入限制的网页页面模拟用户输入用户名和密码,模拟用户点击行为,通过登入验证。(具体怎么实现)根据本专利技术的另一面,还提供一种自动化采集网页数据的方式,包括以下步骤:步骤S10:平台数据库下发指定数据采集请求;步骤S20:登录待采集网站:嵌入式浏览器接收指定数据采集请求并访问指定的待采集网站,访问成功后接收到页面加载风波,同时获取页面加载完成后的内存地址;步骤S30:加载JS脚本:脚本引擎模块为当前页面加载JS脚本,在当前页面的内存地址中执行自定义JS函数;步骤S40:执行预配置的数据采集流程:流程控制模块按照预配置的流程执行批处理命令,按照批处理的执行流程逐渐执行,到预配置的页面采集指定数据;步骤S50:上传采集结果:将采集到的指定数据通过网路上传至所述平台数据库。

优选地,所述步骤S20中,当指定的待采集网站有登录限制时,所述脚本引擎模块和所述流程控制模块模拟用户输入用户名和密码,模拟用户点击行为,通过登入验证。与现有技术相比,本专利技术的有益疗效为:(1)在嵌入式浏览器基础上降低了脚本引擎模块和流程控制模块,结合上述两个模块共同实现对指定网页的自动化访问和采集,通过流程控制模块可以定做具体页面上的采集内容,适用于对具体网页的数据进行精确处理或则是针对具体网页进行特殊处理,特别是对于税务网站的数据才能进行精确采集;可以实现采集流程自定义、采集内容自定义;(2)针对存在登入限制的网页页面,利用脚本引擎模块和流程控制模块可以模拟用户输入用户名和密码,模拟用户点击行为,通过登入验证,进行自动化数据采集。附图说明图1为本专利技术施行例1的一种自动化采集网页数据的系统的结构图;图2为本专利技术施行例1的一种自动化采集网页数据的方式的流程图。其中,1-嵌入式浏览器,2-API接口,3-脚本引擎模块,4-流程控制模块。具体施行方法为让对本专利技术的目的、构造、特征、及其功能有进一步的了解,兹配合施行例详尽说明如下。实施例1:请参见图1,图1为本专利技术施行例1的一种自动化采集网页数据的系统的结构图,本专利技术施行例1的一种自动化采集网页数据的系统,包括嵌入式浏览器1、API接口2、脚本引擎模块3和流程控制模块4,API接口2与脚本引擎模块3、流程控制模块4分别嵌入嵌入式浏览器1。

本专利技术的自动化采集网页数据的系统结合脚本引擎模块3和流程控制模块4共同实现对指定网页的访问和指定数据采集。优选地,脚本引擎模块3用于加载JS脚本;JS脚本收录操作网页的自定义JS函数,对网页的执行动作须要JS脚本解释执行;当网页数据加载到计算机显存中后,JS脚本加载到脚本引擎模块3中,用来在当前页面的内存地址中执行自定义JS函数,支撑网页数据采集过程。脚本引擎模块3促使本专利技术的自动化采集网页数据的系统具有在当前页面的内存地址中执行自定义的JS函数的能力,脚本引擎模块3在网页加载完成后就能获取当前页面的内存地址,并借助JS脚本模拟用户的各类点击操作,采集dom元素(即Web页面上的对象及元素)上的内容。优选地,流程控制模块4用于承载并执行批处理的命令,执行预配置的数据采集流程;其中,批处理的命令为查询按键的点击、页面的跳转或则是网页数据的采集,每一条命令可能是一次查询按键的点击,或者一次页面的跳转,或者是网页数据的采集。传统的自动化采集系统只是按照固定的采集算法去批量采集页面数据,但是未能针对不同的页面进行不同的特殊处理,本专利技术的流程控制模块4支持流程自定义控制,支持任意订制采集内容,具有较强的灵活性,特别是在精确采集税务网站数据方面具有无可比拟的优势。

传统的自动化采集系统未能采集存在登入限制的网页页面的数据,具有较大的局限性。本专利技术的脚本引擎模块3和流程控制模块4结合上去还用于在登入限制的网页页面模拟用户输入用户名和密码,模拟用户点击行为,通过登陆验证。实施例2:根据本专利技术的另一面,还提供一种自动化采集网页数据的方式,请参见图2,图2为本专利技术施行例1的一种自动化采集网页数据的方式的流程图,本专利技术施行例1的一种自动化采集网页数据的方式包括以下步骤:步骤S10:平台数据库下发指定数据采集请求;步骤S20:登录待采集网站:嵌入式浏览器1接收指定数据采集请求并访问指定的待采集网站,访问成功后接收到页面加载风波,同时获取页面加载完成后的内存地址;步骤S30:加载JS脚本:脚本引擎模块3为当前页面加载JS脚本,在当前页面的内存地址中执行自定义JS函数;步骤S40:执行预配置的数据采集流程:流程控制模块4按照预配置的流程执行批处理命令,按照批处理的执行流程逐渐执行,到预配置的页面采集指定数据;步骤S50:上传采集结果:将采集到的指定数据通过网路上传至平台数据库。优选地,步骤S20中,当指定的待采集网站有登录限制时,脚本引擎模块3和流程控制模块4模拟用户输入用户名和密码,模拟用户点击行为,通过登陆验证。实施例3:本专利技术的自动化采集网页数据的系统及技巧应用场景广泛,例如可以应用于采集税务网站的网页数据,为顾客提供智能财税服务,利用顾客提供的帐号信息登陆税局网站,采集相关的财税数据信息,获取顾客在税务网站上的基本信息和财务信息,为智能财税服务提供数据支撑,为顾客

【技术保护点】

1.一种自动化采集网页数据的系统,其特点在于:包括嵌入式浏览器、API接口、脚本引擎模块和流程控制模块,所述API插口与所述脚本引擎模块、所述流程控制模块嵌入所述嵌入式浏览器中。/n

【技术特点摘要】

1.一种自动化采集网页数据的系统,其特点在于:包括嵌入式浏览器、API接口、脚本引擎模块和流程控制模块,所述API插口与所述脚本引擎模块、所述流程控制模块嵌入所述嵌入式浏览器中。

2.如权力要求1所述的自动化采集网页数据的系统,其特点在于:所述脚本引擎模块用于加载JS脚本;所述JS脚本收录操作网页的自定义JS函数,当网页数据加载到计算机显存中后,所述JS脚本加载到所述脚本引擎模块中,用来在当前页面的内存地址中执行所述自定义JS函数,支撑网页数据采集过程。

3.如权力要求1所述的自动化采集网页数据的系统,其特点在于:所述流程控制模块用于承载并执行批处理的命令,执行预配置的数据采集流程。

4.如权力要求3所述的自动化采集网页数据的系统,其特点在于:所述批处理的命令为查询按键的点击、页面的跳转或则是网页数据的采集。

5.如权力要求1所述的自动化采集网页数据的系统,其特点在于:所述脚本引擎模块和所述流程控制模块结合上去还用于在登入限制...

【专利技术属性】

技术研制人员:李沁,李娜,

申请(专利权)人:南京云帐房网络科技有限公司,

类型:发明

国别省市:江苏;32

全部详尽技术资料下载 我是这个专利的主人

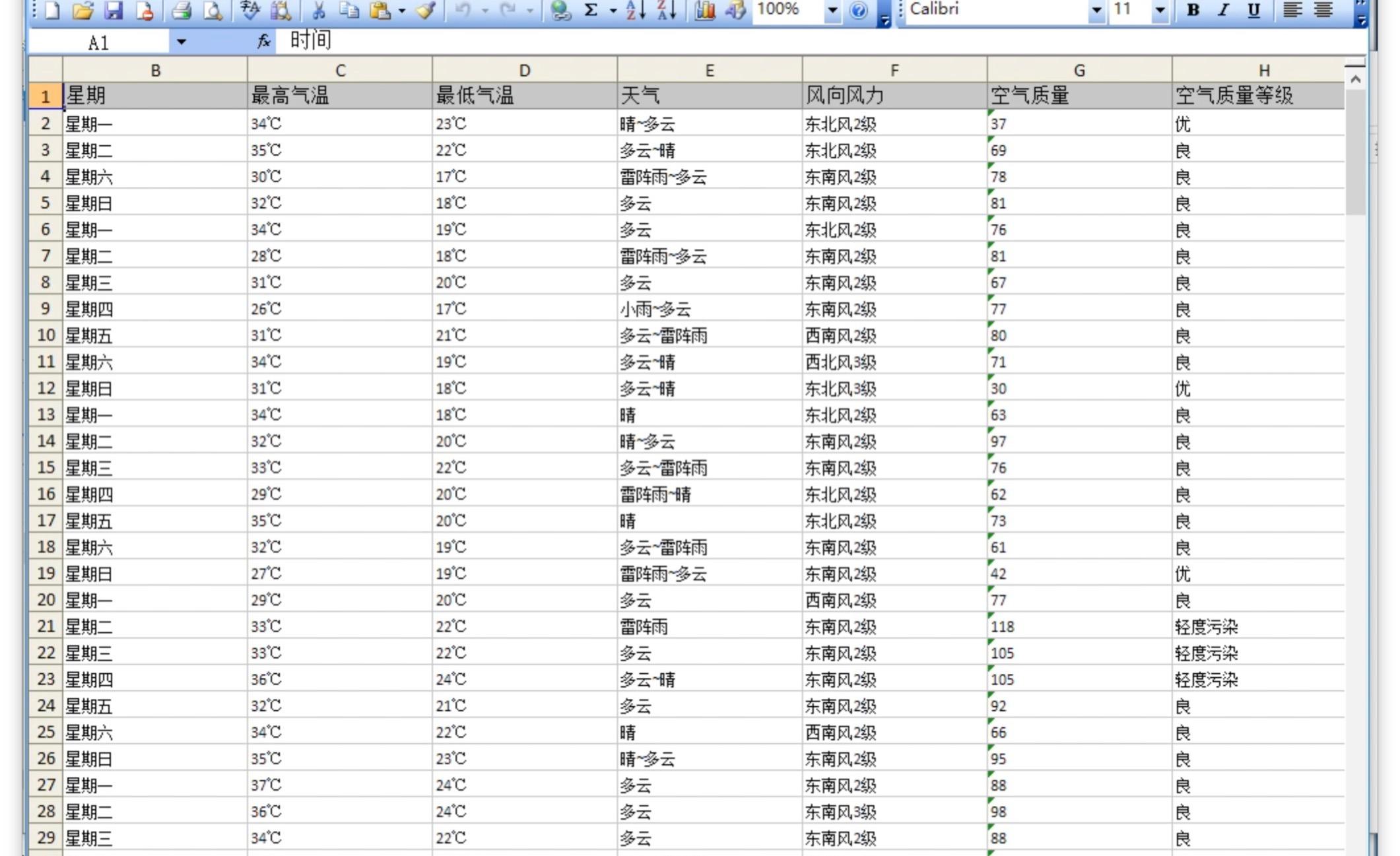

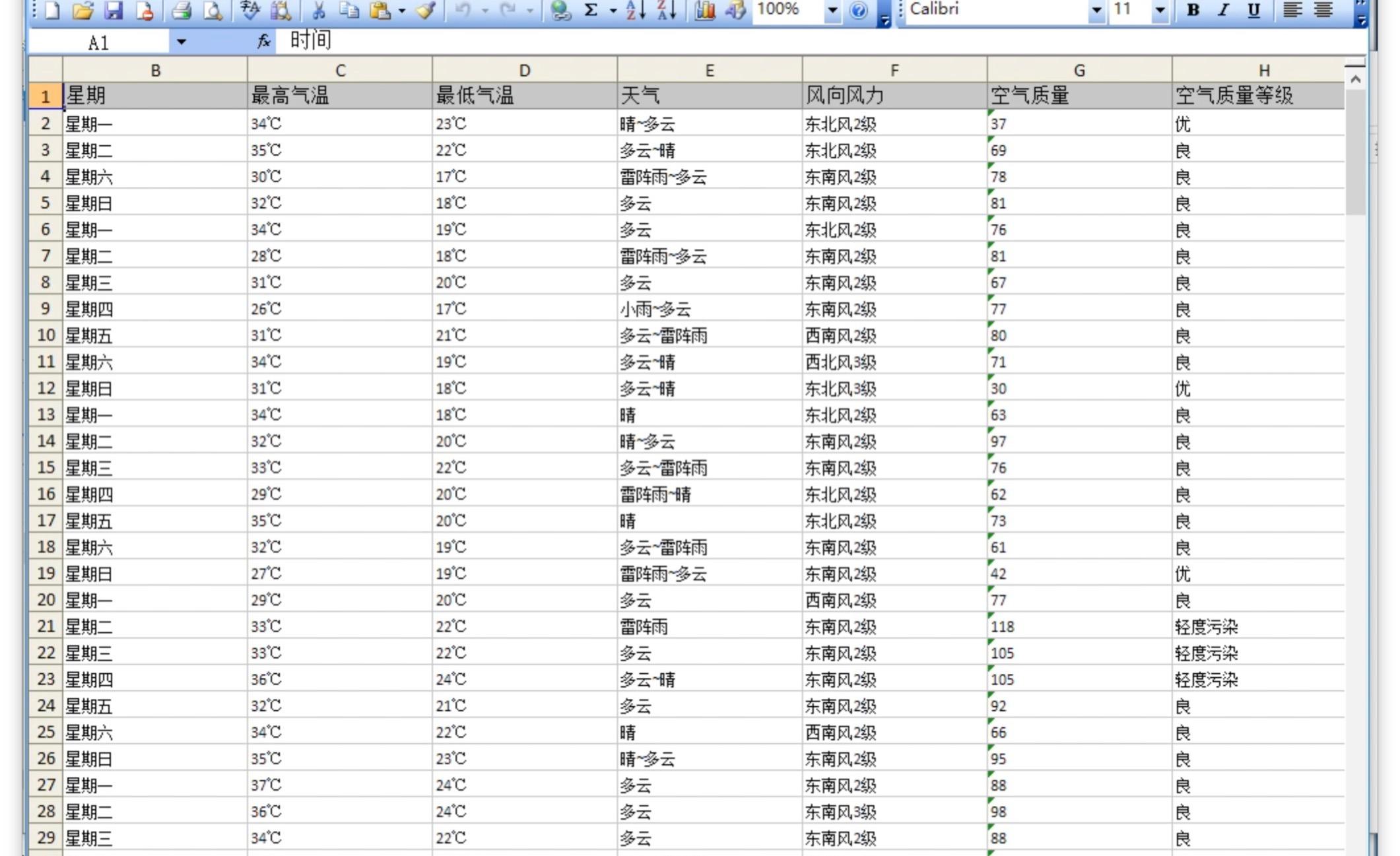

优采云采集器怎么采集历史天气数据这类直接就是表格的数据?

采集交流 • 优采云 发表了文章 • 0 个评论 • 361 次浏览 • 2020-08-30 04:28

感谢约请,废话不多,直接上操作视频~

优采云采集器智能采集天气网

我试了一下,楼主说的问题确实存在,同时我对比测试了一下优采云采集器对天气网的采集,使用楼主提供的链接,大概2分钟左右就完成了对所有天气数据及历史数据的采集设置。同时我也把我的操作过程录屏出来,楼主可以根据我的操作过程自己采集。

我说几点感受吧:

1. 这个网站确实很简单的表格,但是翻页的时侯网址不变,这种网页技术称作局部刷新,或者专业点叫Ajax,感兴趣可以百度下,不过也可以不用管,在视频中可以看出,在设置翻页采集点击上一个月的时侯,优采云准确的辨识了这个按键的操作,并手动设置了可视化的采集流程,非常形象直观,一看就明白。

2. 在智能辨识的过程中,考验的是算法能力,从这儿也可以看出,优采云对比其他采集器在网页智能辨识算法上表现更好,不仅手动辨识了所有数组,还完整手动辨识了整个列表。同时手动辨识了翻页按键所采用的特殊防采集技术。

我非常说明一下,优采云采集器作为行业典范,是十分关注用户体验的,虽然视频中我是用的是优采云旗舰版本(云采集,api,贴身客服那些对企业级大量数据稳定采集来说都是特别贴心的服务),But,免费版本的优采云是没有任何基本功能限制的,从优采云官方网站(优采云三个字的汉语拼音)直接下载安装优采云即可采集所有网站,对于易迅,天猫,大众点评,百度等各行业主流网站,优采云还提供了外置采集模板,无需配置采集规则即可采集主流大站的数据。

优采云采集器 - 免费网路爬虫软件_网页数据抓取工具

欢迎关注或则私信我交流~ 查看全部

优采云采集器怎么采集历史天气数据这类直接就是表格的数据?

感谢约请,废话不多,直接上操作视频~

优采云采集器智能采集天气网

我试了一下,楼主说的问题确实存在,同时我对比测试了一下优采云采集器对天气网的采集,使用楼主提供的链接,大概2分钟左右就完成了对所有天气数据及历史数据的采集设置。同时我也把我的操作过程录屏出来,楼主可以根据我的操作过程自己采集。

我说几点感受吧:

1. 这个网站确实很简单的表格,但是翻页的时侯网址不变,这种网页技术称作局部刷新,或者专业点叫Ajax,感兴趣可以百度下,不过也可以不用管,在视频中可以看出,在设置翻页采集点击上一个月的时侯,优采云准确的辨识了这个按键的操作,并手动设置了可视化的采集流程,非常形象直观,一看就明白。

2. 在智能辨识的过程中,考验的是算法能力,从这儿也可以看出,优采云对比其他采集器在网页智能辨识算法上表现更好,不仅手动辨识了所有数组,还完整手动辨识了整个列表。同时手动辨识了翻页按键所采用的特殊防采集技术。

我非常说明一下,优采云采集器作为行业典范,是十分关注用户体验的,虽然视频中我是用的是优采云旗舰版本(云采集,api,贴身客服那些对企业级大量数据稳定采集来说都是特别贴心的服务),But,免费版本的优采云是没有任何基本功能限制的,从优采云官方网站(优采云三个字的汉语拼音)直接下载安装优采云即可采集所有网站,对于易迅,天猫,大众点评,百度等各行业主流网站,优采云还提供了外置采集模板,无需配置采集规则即可采集主流大站的数据。

优采云采集器 - 免费网路爬虫软件_网页数据抓取工具

欢迎关注或则私信我交流~

Boxoft Audio Converter与网站万能信息采集器终极版下载评论软

采集交流 • 优采云 发表了文章 • 0 个评论 • 326 次浏览 • 2020-08-29 17:21

5年来不断的建立改进缔造了史无前例的强悍采集软件--网站万能信息采集器。

网站优采云采集器:能看到的信息都能抓到.

八大特色功能:

1.信息采集添加全手动

网站抓取的目的主要是添加到您的网站中,软件可以实现采集添加全手动完成。其它网站刚刚更新的信息五分钟之内都会手动挪到您的网站中.

2.需要登入的网站也照抓

对于须要登陆能够听到信息内容的网站,网站优采云采集器可以实现轻松登陆并采集,即使有验证码也可以穿过登陆采集到您须要的信息。

3.任意类型的文件都能下载

如果须要采集图片等二进制文件,经过简单设置网站优采云采集器就可以把任意类型的文件保存到本地。

4.多级页面采集

可以同时采集到多级页面的内容。如果一条信息分布在好多不同的页面上,网站优采云采集器也能手动识

别多级页面实现采集

5.自动辨识JavaScript等特殊网址

不少网站的网页联接是类似javascript:openwin('1234')这样的特殊网址,不是一般的开头的,软件也能手动辨识并抓到内容

6.自动获取各个分类网址

比如供求信息,往往有很多好多个分类,经过简单设置软件就可以手动抓到那些分类网址,并把抓到的信息手动分类

7.多页新闻手动抓取、广告过滤

有些一条新闻上面还有下一页,软件也可以把各个页面都抓到的。并且抓到的新闻中的图片和文字同时可以保存出来,并能把广告过滤掉

8.自动破解防盗链

很多下载类的网站都做了防盗链了,直接输入网址是抓不到内容的,但是软件中能手动破解防盗链,,确保您能抓到想要的东西

另加入了模拟人工递交的功能,租用的网站asp+access空间也能远程发布了,实际上能够模拟一切网页递交动作,可以批量注册会员、模拟群发消息。 查看全部

Boxoft Audio Converter与网站万能信息采集器终极版下载评论软

5年来不断的建立改进缔造了史无前例的强悍采集软件--网站万能信息采集器。

网站优采云采集器:能看到的信息都能抓到.

八大特色功能:

1.信息采集添加全手动

网站抓取的目的主要是添加到您的网站中,软件可以实现采集添加全手动完成。其它网站刚刚更新的信息五分钟之内都会手动挪到您的网站中.

2.需要登入的网站也照抓

对于须要登陆能够听到信息内容的网站,网站优采云采集器可以实现轻松登陆并采集,即使有验证码也可以穿过登陆采集到您须要的信息。

3.任意类型的文件都能下载

如果须要采集图片等二进制文件,经过简单设置网站优采云采集器就可以把任意类型的文件保存到本地。

4.多级页面采集

可以同时采集到多级页面的内容。如果一条信息分布在好多不同的页面上,网站优采云采集器也能手动识

别多级页面实现采集

5.自动辨识JavaScript等特殊网址

不少网站的网页联接是类似javascript:openwin('1234')这样的特殊网址,不是一般的开头的,软件也能手动辨识并抓到内容

6.自动获取各个分类网址

比如供求信息,往往有很多好多个分类,经过简单设置软件就可以手动抓到那些分类网址,并把抓到的信息手动分类

7.多页新闻手动抓取、广告过滤

有些一条新闻上面还有下一页,软件也可以把各个页面都抓到的。并且抓到的新闻中的图片和文字同时可以保存出来,并能把广告过滤掉

8.自动破解防盗链

很多下载类的网站都做了防盗链了,直接输入网址是抓不到内容的,但是软件中能手动破解防盗链,,确保您能抓到想要的东西

另加入了模拟人工递交的功能,租用的网站asp+access空间也能远程发布了,实际上能够模拟一切网页递交动作,可以批量注册会员、模拟群发消息。

汇总:优采云采集器与ABC Amber DBISAM Converter 2

采集交流 • 优采云 发表了文章 • 0 个评论 • 312 次浏览 • 2020-08-29 09:26

增加导入采集数据到JSON文件功能

Bug修补

解决自定义配置中拖动步骤到判别条件中异常的问题

解决自定义配置中多次复制数组后造成数组遗失的问题

解决自定义配置中在数据预览中操作数组相关的问题

解决自定义配置中有时不同网页内容重叠在一起的问题

解决部份任务本地采集时错误的提示须要补采的问题

解决自定义配置中编辑任务后未显示更改未保存标示的问题

解决采集模板详情中有时信息显示不全的问题

解决自定义配置中流程图添加采集步骤菜单显示不全的问题

解决自定义配置中流程图中有时循环项显示不正确的问题

解决点击侧边菜单栏近来编辑任务打开任务不显示网页的问题

优采云采集器8.1.14

主要体验改进

自定义任务配置中降低列表相关的设置引导

自定义任务配置中降低网页中没有要采集数据时的设置引导

自定义任务配置中优化测量到Ajax后的设置引导

自定义任务配置中优化手动辨识结果的设置引导

自定义任务配置中加入表单类是网页手动辨识,识别率约80%+

Bug修补

解决优采云打开后,电脑长时间睡眠,重新唤起后优采云白屏问题

优采云采集器8.1.12

主要体验改进

本地采集增加了对7版本采集任务的正则兼容

优化自定义配置中在全部数组中删掉数组后预览数据的刷新机制

Bug修补

解决自定义配置中添加采集步骤菜单显示位置不正确的问题

解决升级新版本后任务列表打不开的问题

解决自定义配置中拖动调整数据预览中主键次序死机的问题

解决自定义配置中删掉数据预览中数组或数据行时提示操作框显示错误的问题

解决采集模板中列表类型的参数难以配置的问题

解决本地采集中键盘联通到元素上不生效的问题

解决定时采集中设置日期会出错的问题

解决自定义配置中JSON任务添加数组会死机的问题

解决任务列表中任务组模式下批量启动云采集会长时间卡住的问题

解决自定义配置中添加固定数组后更改数组名错误的问题

解决自定义配置中循环提取固定元素列表预览数据不显示的问题

解决自定义配置中部份网站无法获取Cookie的问题

解决定时采集中设置按周、按月定时采集下一次采集时间不正确的问题

解决定时采集中设置间隔时间1分钟采集不生效的问题

解决自定义配置中有时更改任务名保存不生效的问题

解决自定义配置中设置数组抓取属性值-选择属性值的时侯流程图区域会隐藏的问题

解决自定义配置中第一次步入时引导提示背景出现用户调查界面的问题

解决任务列表中刷新后筛选条件重置的问题

解决自定义配置中更改任务名时标签页中的任务保存标示不正确的问题

优采云采集器8.1.8

主要体验改进:

改善安装卸载错误日志记录方法

优采云采集器8.1.4

主要体验改进

优化网页列表数据手动辨识,将识别率提升到90%以上

Bug修补

解决自定义配置中循环输入文本中循环项重复的问题

解决自定义配置当前页面数据预览中有时会多出一列空数据的问题

解决自定义配置中有时候手动辨识生成的采集流程不正确的问题

解决自定义配置当前页面数据预览中拖动改变数组次序后更改数组名错误的问题

解决本地采集中部份网页Cookie不生效问题

解决自定义配置中手动辨识生成的采集字段中有空格的问题

解决本地采集中部份网站无法滚动加载数据的问题

解决本地采集中个别情况下数据低格不正确的问题

解决自定义配置提取数据配置中更改数组后没有应用也生效的问题

解决自定义配置中部份网页手动辨识有时会卡住的问题

解决自定义配置手动辨识的数据预览中有时更改数组名会死机的问题

解决主界面两侧帐户过期时间显示的问题

解决自定义配置中个别操作会导致流程图错乱的问题

优采云采集器7.4.42018-06-22

主要体验改进:

【自定义模式】支持采集网址数目,从2万扩充到100万级别

【自定义模式】网址输入支持文本导出,支持txt、xls、xlsx、csv格式

【自定义模式】网址输入支持批量生成网址参数,包括数字变化、字母变化、时间变化、自定义类表四种生成方法

【自定义模式】支持任务追随采集,A采集的网址作为B任务的输入源进行关联采集,拓宽使用场景

【任务列表】任务列表可依照「云采集完成时间」来排序

【其他】任务错误报告导入支持excel格式

Bug修补:

修复本地验证码辨识出错问题

修复云采集正则替换失效问题

优采云采集器V7.2.2 2017-12-25

升级提醒:

系统不支持手动从6.x手动升级到7.x,使用6.x版的用户请单独下载V7.x版本再安装使用。

主要体验改进:

【任务管理】可自定义每页显示任务数目(10、20、50、100),大批量任务管理更方便

【任务管理】优化页面刷新体验,减少无效刷新

【自定义模式】可将无关联的几个元素,组成一组列表链接进行循环采集,适应更多场景需求

【自定义模式】创建任务时,可同时设置任务组

【其他】可选购任务控制API

Bug修补:

修复增量采集失效问题,提高增量采集可靠性

修复填入大量URL时造成的性能问题

修复部份客户端崩溃问题

优采云采集器V7.1.82017-11-19

升级提醒:

系统不支持手动从6.x手动升级到7.x,使用6.x版的用户请先卸载:开始->优采云->卸载,再安装V7.x。

主要体验改进: 查看全部

优采云采集器与ABC Amber DBISAM Converter 2

增加导入采集数据到JSON文件功能

Bug修补

解决自定义配置中拖动步骤到判别条件中异常的问题

解决自定义配置中多次复制数组后造成数组遗失的问题

解决自定义配置中在数据预览中操作数组相关的问题

解决自定义配置中有时不同网页内容重叠在一起的问题

解决部份任务本地采集时错误的提示须要补采的问题

解决自定义配置中编辑任务后未显示更改未保存标示的问题

解决采集模板详情中有时信息显示不全的问题

解决自定义配置中流程图添加采集步骤菜单显示不全的问题

解决自定义配置中流程图中有时循环项显示不正确的问题

解决点击侧边菜单栏近来编辑任务打开任务不显示网页的问题

优采云采集器8.1.14

主要体验改进

自定义任务配置中降低列表相关的设置引导

自定义任务配置中降低网页中没有要采集数据时的设置引导

自定义任务配置中优化测量到Ajax后的设置引导

自定义任务配置中优化手动辨识结果的设置引导

自定义任务配置中加入表单类是网页手动辨识,识别率约80%+

Bug修补

解决优采云打开后,电脑长时间睡眠,重新唤起后优采云白屏问题

优采云采集器8.1.12

主要体验改进

本地采集增加了对7版本采集任务的正则兼容

优化自定义配置中在全部数组中删掉数组后预览数据的刷新机制

Bug修补

解决自定义配置中添加采集步骤菜单显示位置不正确的问题

解决升级新版本后任务列表打不开的问题

解决自定义配置中拖动调整数据预览中主键次序死机的问题

解决自定义配置中删掉数据预览中数组或数据行时提示操作框显示错误的问题

解决采集模板中列表类型的参数难以配置的问题

解决本地采集中键盘联通到元素上不生效的问题

解决定时采集中设置日期会出错的问题

解决自定义配置中JSON任务添加数组会死机的问题

解决任务列表中任务组模式下批量启动云采集会长时间卡住的问题

解决自定义配置中添加固定数组后更改数组名错误的问题

解决自定义配置中循环提取固定元素列表预览数据不显示的问题

解决自定义配置中部份网站无法获取Cookie的问题

解决定时采集中设置按周、按月定时采集下一次采集时间不正确的问题

解决定时采集中设置间隔时间1分钟采集不生效的问题

解决自定义配置中有时更改任务名保存不生效的问题

解决自定义配置中设置数组抓取属性值-选择属性值的时侯流程图区域会隐藏的问题

解决自定义配置中第一次步入时引导提示背景出现用户调查界面的问题

解决任务列表中刷新后筛选条件重置的问题

解决自定义配置中更改任务名时标签页中的任务保存标示不正确的问题

优采云采集器8.1.8

主要体验改进:

改善安装卸载错误日志记录方法

优采云采集器8.1.4

主要体验改进

优化网页列表数据手动辨识,将识别率提升到90%以上

Bug修补

解决自定义配置中循环输入文本中循环项重复的问题

解决自定义配置当前页面数据预览中有时会多出一列空数据的问题

解决自定义配置中有时候手动辨识生成的采集流程不正确的问题

解决自定义配置当前页面数据预览中拖动改变数组次序后更改数组名错误的问题

解决本地采集中部份网页Cookie不生效问题

解决自定义配置中手动辨识生成的采集字段中有空格的问题

解决本地采集中部份网站无法滚动加载数据的问题

解决本地采集中个别情况下数据低格不正确的问题

解决自定义配置提取数据配置中更改数组后没有应用也生效的问题

解决自定义配置中部份网页手动辨识有时会卡住的问题

解决自定义配置手动辨识的数据预览中有时更改数组名会死机的问题

解决主界面两侧帐户过期时间显示的问题

解决自定义配置中个别操作会导致流程图错乱的问题

优采云采集器7.4.42018-06-22

主要体验改进:

【自定义模式】支持采集网址数目,从2万扩充到100万级别

【自定义模式】网址输入支持文本导出,支持txt、xls、xlsx、csv格式

【自定义模式】网址输入支持批量生成网址参数,包括数字变化、字母变化、时间变化、自定义类表四种生成方法

【自定义模式】支持任务追随采集,A采集的网址作为B任务的输入源进行关联采集,拓宽使用场景

【任务列表】任务列表可依照「云采集完成时间」来排序

【其他】任务错误报告导入支持excel格式

Bug修补:

修复本地验证码辨识出错问题

修复云采集正则替换失效问题

优采云采集器V7.2.2 2017-12-25

升级提醒:

系统不支持手动从6.x手动升级到7.x,使用6.x版的用户请单独下载V7.x版本再安装使用。

主要体验改进:

【任务管理】可自定义每页显示任务数目(10、20、50、100),大批量任务管理更方便

【任务管理】优化页面刷新体验,减少无效刷新

【自定义模式】可将无关联的几个元素,组成一组列表链接进行循环采集,适应更多场景需求

【自定义模式】创建任务时,可同时设置任务组

【其他】可选购任务控制API

Bug修补:

修复增量采集失效问题,提高增量采集可靠性

修复填入大量URL时造成的性能问题

修复部份客户端崩溃问题

优采云采集器V7.1.82017-11-19

升级提醒:

系统不支持手动从6.x手动升级到7.x,使用6.x版的用户请先卸载:开始->优采云->卸载,再安装V7.x。