网页采集器的自动识别算法

SmartCamera 高性能单反实时采集识别框架, 支持算法可配置化调优

采集交流 • 优采云 发表了文章 • 0 个评论 • 330 次浏览 • 2020-08-17 01:53

English

SmartCamera 是一个 Android 相机拓展库,提供了一个高度可订制的实时扫描模块才能实时采集并且辨识单反内物体边框是否吻合指定区域。如果认为还不错,欢迎 star,fork。

语言描述上去略显生硬,具体实现的功能如下图所示,适用于身份证,名片,文档等内容的扫描、自动拍摄而且剪裁, 你也可以下载 apk 体验:

SmartCamera-Sample-debug.apk

在单反实现上,SmartCamera 以源码的形式引用了 Google 开源的 CameraView ,并且稍作更改以支持 Camera.PreviewCallback 回调来获取单反预览流。

SmartCameraView 继承于修改后的 CameraView,为其添加了一个选框遮罩视图( MaskView )和一个实时扫描模块( SmartScanner )。其中选框视图即是你听到的单反里面的那层选定框,并配备了一个由上到下的扫描疗效,当然你也可以实现 MaskViewImpl 接口来自定义选框视图。

实时扫描模块( SmartScanner )是本库的核心功能所在,配合单反 PreviewCallback 接口反弹的预览流和选框视图 MaskView 提供的选框区域 RectF,能以不错的性能实时判别出内容是否吻合选框。

你也可以关注我的另一个库 SmartCropper: 一个简单易用的智能图片剪裁库,适用于身份证,名片,文档等合照的剪裁。

扫描算法调优

SmartScanner 提供了丰富的算法配置,使用者可以自己更改扫描算法以获得更好的适配性,阅读附表一提供的各参数使用说明来获得更好的辨识疗效。

为了更方便、高效地调优算法,SmartScanner 贴心地为你提供了扫描预览模式,开启预览功能后,你可以通过 SmartScanner 获取每一帧处理的结果输出到 ImageView 中实时观察 native 层扫描的结果,其中白线区域即为边沿测量的结果,白线加粗区域即为辨识出的边框。

你的目标是通过调节 SmartScanner 的各个参数促使内容边界清晰可见,识别出的边框(白色加粗线段)准确无误。

注:SmartCamera 在各方面做了性能以及显存上的优化,但是出于不必要的性能资源浪费,算法参数调优结束后请关掉预览模式。

接入

1.根目录下的 build.gradle 添加:

allprojects {

repositories {

...

maven { url 'https://jitpack.io' }

}

}

2.添加依赖

dependencies {

implementation 'com.github.pqpo:SmartCamera:v1.0.0'

}

注意:由于使用了 JNI, 请防止混淆

-keep class me.pqpo.smartcameralib.**{*;}

使用1. 引入单反布局,并启动单反(必要时启动预览)

@Override

protected void onResume() {

super.onResume();

mCameraView.start();

mCameraView.startScan();

}

@Override

protected void onPause() {

mCameraView.stop();

super.onPause();

if (alertDialog != null) {

alertDialog.dismiss();

}

mCameraView.stopScan();

}

注:若开启了预览别忘了调用相应开启、结束预览的技巧。

2. 修改扫描模块参数(可选,调优算法,同时按第 4 步中开启预览模式)

扫描模块各个参数含义详见附录一

private void initScannerParams() {

SmartScanner.DEBUG = true;

SmartScanner.detectionRatio = 0.1f;

SmartScanner.checkMinLengthRatio = 0.8f;

SmartScanner.cannyThreshold1 = 20;

SmartScanner.cannyThreshold2 = 50;

SmartScanner.houghLinesThreshold = 130;

SmartScanner.houghLinesMinLineLength = 80;

SmartScanner.houghLinesMaxLineGap = 10;

SmartScanner.firstGaussianBlurRadius = 3;

SmartScanner.secondGaussianBlurRadius = 3;

SmartScanner.maxSize = 300;

SmartScanner.angleThreshold = 5;

// don't forget reload params

SmartScanner.reloadParams();

}

注: 修改参数后别忘掉通知 native 层重新加载参数:SmartScanner.reloadParams();

3. 配置遮罩选框视图(可选,若要更改默认的视图, 或要更改选框区域)

配置 MaskView 各个方法的含义详见附录二

final MaskView maskView = (MaskView) mCameraView.getMaskView();;

maskView.setMaskLineColor(0xff00adb5);

maskView.setShowScanLine(true);

maskView.setScanLineGradient(0xff00adb5, 0x0000adb5);

maskView.setMaskLineWidth(2);

maskView.setMaskRadius(5);

maskView.setScanSpeed(6);

maskView.setScanGradientSpread(80);

mCameraView.post(new Runnable() {

@Override

public void run() {

int width = mCameraView.getWidth();

int height = mCameraView.getHeight();

if (width < height) {

maskView.setMaskSize((int) (width * 0.6f), (int) (width * 0.6f / 0.63));

maskView.setMaskOffset(0, -(int)(width * 0.1));

} else {

maskView.setMaskSize((int) (width * 0.6f), (int) (width * 0.6f * 0.63));

}

}

});

mCameraView.setMaskView(maskView);

4. 配置 SmartCameraView1. 开启预览:

mCameraView.getSmartScanner().setPreview(true);

mCameraView.setOnScanResultListener(new SmartCameraView.OnScanResultListener() {

@Override

public boolean onScanResult(SmartCameraView smartCameraView, int result) {

Bitmap previewBitmap = smartCameraView.getPreviewBitmap();

if (previewBitmap != null) {

ivPreview.setImageBitmap(previewBitmap);

}

return false;

}

});

通过第一句代码开启了预览模式。

你可以通过 setOnScanResultListener 设置反弹获得每一帧的扫描结果,其中 result == 1 表示辨识结果吻合边框

若开启了预览模式,你可以在反弹中使用 smartCameraView.getPreviewBitmap() 方法获取每一帧处理的结果。

返回值为 false 表示不拦截扫描结果,这时 SmartCameraView 内部会在 result 为 1 的情况下手动触发照相,若你自己处理了扫描结果返回 true 即可。

2. 获取照相结果,并且剪裁选框区域:

mCameraView.addCallback(new CameraView.Callback() {

@Override

public void onPictureTaken(CameraView cameraView, byte[] data) {

super.onPictureTaken(cameraView, data);

// 异步裁剪图片

mCameraView.cropImage(data, new SmartCameraView.CropCallback() {

@Override

public void onCropped(Bitmap cropBitmap) {

if (cropBitmap != null) {

showPicture(cropBitmap);

}

}

);

}

});

获取照相结果的反弹是 CameraView 提供的,你只须要在内部调用 SmartCameraView 提供的 cropImage 方法即可获取选框区域内的剪裁图片

注:其他关于 SmartCameraView 的使用方式同 CameraView ,另外更具体的使用方式请参考 app 内代码

附录

见 github

感谢关于我: 查看全部

SmartCamera 高性能单反实时采集识别框架, 支持算法可配置化调优

English

SmartCamera 是一个 Android 相机拓展库,提供了一个高度可订制的实时扫描模块才能实时采集并且辨识单反内物体边框是否吻合指定区域。如果认为还不错,欢迎 star,fork。

语言描述上去略显生硬,具体实现的功能如下图所示,适用于身份证,名片,文档等内容的扫描、自动拍摄而且剪裁, 你也可以下载 apk 体验:

SmartCamera-Sample-debug.apk

在单反实现上,SmartCamera 以源码的形式引用了 Google 开源的 CameraView ,并且稍作更改以支持 Camera.PreviewCallback 回调来获取单反预览流。

SmartCameraView 继承于修改后的 CameraView,为其添加了一个选框遮罩视图( MaskView )和一个实时扫描模块( SmartScanner )。其中选框视图即是你听到的单反里面的那层选定框,并配备了一个由上到下的扫描疗效,当然你也可以实现 MaskViewImpl 接口来自定义选框视图。

实时扫描模块( SmartScanner )是本库的核心功能所在,配合单反 PreviewCallback 接口反弹的预览流和选框视图 MaskView 提供的选框区域 RectF,能以不错的性能实时判别出内容是否吻合选框。

你也可以关注我的另一个库 SmartCropper: 一个简单易用的智能图片剪裁库,适用于身份证,名片,文档等合照的剪裁。

扫描算法调优

SmartScanner 提供了丰富的算法配置,使用者可以自己更改扫描算法以获得更好的适配性,阅读附表一提供的各参数使用说明来获得更好的辨识疗效。

为了更方便、高效地调优算法,SmartScanner 贴心地为你提供了扫描预览模式,开启预览功能后,你可以通过 SmartScanner 获取每一帧处理的结果输出到 ImageView 中实时观察 native 层扫描的结果,其中白线区域即为边沿测量的结果,白线加粗区域即为辨识出的边框。

你的目标是通过调节 SmartScanner 的各个参数促使内容边界清晰可见,识别出的边框(白色加粗线段)准确无误。

注:SmartCamera 在各方面做了性能以及显存上的优化,但是出于不必要的性能资源浪费,算法参数调优结束后请关掉预览模式。

接入

1.根目录下的 build.gradle 添加:

allprojects {

repositories {

...

maven { url 'https://jitpack.io' }

}

}

2.添加依赖

dependencies {

implementation 'com.github.pqpo:SmartCamera:v1.0.0'

}

注意:由于使用了 JNI, 请防止混淆

-keep class me.pqpo.smartcameralib.**{*;}

使用1. 引入单反布局,并启动单反(必要时启动预览)

@Override

protected void onResume() {

super.onResume();

mCameraView.start();

mCameraView.startScan();

}

@Override

protected void onPause() {

mCameraView.stop();

super.onPause();

if (alertDialog != null) {

alertDialog.dismiss();

}

mCameraView.stopScan();

}

注:若开启了预览别忘了调用相应开启、结束预览的技巧。

2. 修改扫描模块参数(可选,调优算法,同时按第 4 步中开启预览模式)

扫描模块各个参数含义详见附录一

private void initScannerParams() {

SmartScanner.DEBUG = true;

SmartScanner.detectionRatio = 0.1f;

SmartScanner.checkMinLengthRatio = 0.8f;

SmartScanner.cannyThreshold1 = 20;

SmartScanner.cannyThreshold2 = 50;

SmartScanner.houghLinesThreshold = 130;

SmartScanner.houghLinesMinLineLength = 80;

SmartScanner.houghLinesMaxLineGap = 10;

SmartScanner.firstGaussianBlurRadius = 3;

SmartScanner.secondGaussianBlurRadius = 3;

SmartScanner.maxSize = 300;

SmartScanner.angleThreshold = 5;

// don't forget reload params

SmartScanner.reloadParams();

}

注: 修改参数后别忘掉通知 native 层重新加载参数:SmartScanner.reloadParams();

3. 配置遮罩选框视图(可选,若要更改默认的视图, 或要更改选框区域)

配置 MaskView 各个方法的含义详见附录二

final MaskView maskView = (MaskView) mCameraView.getMaskView();;

maskView.setMaskLineColor(0xff00adb5);

maskView.setShowScanLine(true);

maskView.setScanLineGradient(0xff00adb5, 0x0000adb5);

maskView.setMaskLineWidth(2);

maskView.setMaskRadius(5);

maskView.setScanSpeed(6);

maskView.setScanGradientSpread(80);

mCameraView.post(new Runnable() {

@Override

public void run() {

int width = mCameraView.getWidth();

int height = mCameraView.getHeight();

if (width < height) {

maskView.setMaskSize((int) (width * 0.6f), (int) (width * 0.6f / 0.63));

maskView.setMaskOffset(0, -(int)(width * 0.1));

} else {

maskView.setMaskSize((int) (width * 0.6f), (int) (width * 0.6f * 0.63));

}

}

});

mCameraView.setMaskView(maskView);

4. 配置 SmartCameraView1. 开启预览:

mCameraView.getSmartScanner().setPreview(true);

mCameraView.setOnScanResultListener(new SmartCameraView.OnScanResultListener() {

@Override

public boolean onScanResult(SmartCameraView smartCameraView, int result) {

Bitmap previewBitmap = smartCameraView.getPreviewBitmap();

if (previewBitmap != null) {

ivPreview.setImageBitmap(previewBitmap);

}

return false;

}

});

通过第一句代码开启了预览模式。

你可以通过 setOnScanResultListener 设置反弹获得每一帧的扫描结果,其中 result == 1 表示辨识结果吻合边框

若开启了预览模式,你可以在反弹中使用 smartCameraView.getPreviewBitmap() 方法获取每一帧处理的结果。

返回值为 false 表示不拦截扫描结果,这时 SmartCameraView 内部会在 result 为 1 的情况下手动触发照相,若你自己处理了扫描结果返回 true 即可。

2. 获取照相结果,并且剪裁选框区域:

mCameraView.addCallback(new CameraView.Callback() {

@Override

public void onPictureTaken(CameraView cameraView, byte[] data) {

super.onPictureTaken(cameraView, data);

// 异步裁剪图片

mCameraView.cropImage(data, new SmartCameraView.CropCallback() {

@Override

public void onCropped(Bitmap cropBitmap) {

if (cropBitmap != null) {

showPicture(cropBitmap);

}

}

);

}

});

获取照相结果的反弹是 CameraView 提供的,你只须要在内部调用 SmartCameraView 提供的 cropImage 方法即可获取选框区域内的剪裁图片

注:其他关于 SmartCameraView 的使用方式同 CameraView ,另外更具体的使用方式请参考 app 内代码

附录

见 github

感谢关于我:

疯子网页采集器教程之采集需要保存图片的教程

采集交流 • 优采云 发表了文章 • 0 个评论 • 299 次浏览 • 2020-08-16 21:38

基于MATLAB的Filter使用,低通、带通和高通滤波器的仿真08-26

基于MATLAB的Filter使用,低通、带通和高通滤波器的仿真。包括filter、ftt等函数的使用

puiying的博客

07-06

2716

5分钟快速安装优采云采集器

简介优采云采集器是一款免费的数据采集发布爬虫软件,采用php+mysql开发,可布署在云服务器,几乎能采集所有类型的网页,无缝对接各种CMS建站程序,免登入实时发布数据,全手动无需人工干预。安装为了便捷布署和解决环境兼容性等问题,采用docker来布署安装skycaiji。首先安装Docker容器管理面板URLOS,请参考官方文档:

求助,怎么做一个网页填表程序,把图片上传到网页

11-27

这个是我提取的id 这个是我点击游玩后,弹出一个选择本地笔记本图片的窗口,双击本地图片后,显示的状况。 这个是保存的botton 我想通过程序完成网页的图片游玩,保存功能。 请前辈帮帮忙

结构之法 算法之道

09-28

40万+

BAT机器学习笔试1000题系列(第1~305题)

BAT机器学习笔试1000题系列整理:July、元超、立娜、德伟、贾茹、王剑、AntZ、孟莹等众人。本系列大部分题目来源于公开网路,取之分享,用之分享,且在撰写答案过程中若引用别人解析则必标明原作者及来源链接。另,不少答案得到寒小阳、管博士、张雨石、王赟、褚博士等七月在线名师审校。说明:本系列作为国外首个AI题库,首发于七月在线实验室公众号上:julyedulab,并部份更新......

过往记忆大数据

09-25

854

史上最全的大数据学习资源(Awesome Big Data)

为了使你们更好地学习交流,过往记忆大数据花了一个假期的时间把Awesome Big Data里逾 600 个大数据相关的调度、存储、计算、数据库以及可视化等介绍全部翻译了一遍,供你们学习交流。关系型数据库管理系统MySQL世界上最流行的开源数据库。PostgreSQL世界上最先进的开源数据库。Oracle Database- 对象关系数据库管理系统。Teradat......

weixin_34122548的博客

12-08

106

微服务核心构架梳理

在公司学习了接近一个月。 一个月内,从0开始开始接触分布式微服务构架,给了我不小的收获。今天,我来从头到尾梳理一下,有关微服务构架的核心内容(全是干货)。下文,你将见到业界主流微服务框架的核心原理,包括服务发觉,网关,配置中心,监控等组件,功能和构架原理的简单介绍。感谢阅读!...

GitChat

11-06

130

Python 数据科学入门

内容简介本书以 Python 语言讲解数据科学基础知识,涵盖了数据采集、清洗、存储、检索、转换、可视化、数据剖析(网络剖析)、统计和机器学习等内容。具体内容包括:数据科学的 Python 核心特点,文本数据、数据库、表格方式的数值数据、series 和 frame、网络数据的使用,数据的勾画,概率与统计,机器学习。 《Python 数据科学入门》面向研究生和本科生、数据科学教员、刚入门的数据科......

R先生三天不学习就四肢难过

10-27

6161

来来来,看看有没有适宜你的物联网操作系统

前言操作系统是物联网时代的战略制高点,今天 PC 和手机时代的操作系统霸主未必能在物联网时代延续霸业。操作系统产业的规律是,当垄断早已产生,后来者就很难颠覆,只有等待下一次产业浪潮。如今,一个全新的、充满想像空间的操作系统市场机会正在开启。 如此关键的产业环节必然是兵家必争之地。ARM、谷歌、微软、华为、阿里、海尔等国内外知名的 IT 企业纷纷推出物联网操作系统,整个产业呈现出群雄逐鹿的壮... 查看全部

疯子网页采集器教程之采集需要保存图片的教程

基于MATLAB的Filter使用,低通、带通和高通滤波器的仿真08-26

基于MATLAB的Filter使用,低通、带通和高通滤波器的仿真。包括filter、ftt等函数的使用

puiying的博客

07-06

2716

5分钟快速安装优采云采集器

简介优采云采集器是一款免费的数据采集发布爬虫软件,采用php+mysql开发,可布署在云服务器,几乎能采集所有类型的网页,无缝对接各种CMS建站程序,免登入实时发布数据,全手动无需人工干预。安装为了便捷布署和解决环境兼容性等问题,采用docker来布署安装skycaiji。首先安装Docker容器管理面板URLOS,请参考官方文档:

求助,怎么做一个网页填表程序,把图片上传到网页

11-27

这个是我提取的id 这个是我点击游玩后,弹出一个选择本地笔记本图片的窗口,双击本地图片后,显示的状况。 这个是保存的botton 我想通过程序完成网页的图片游玩,保存功能。 请前辈帮帮忙

结构之法 算法之道

09-28

40万+

BAT机器学习笔试1000题系列(第1~305题)

BAT机器学习笔试1000题系列整理:July、元超、立娜、德伟、贾茹、王剑、AntZ、孟莹等众人。本系列大部分题目来源于公开网路,取之分享,用之分享,且在撰写答案过程中若引用别人解析则必标明原作者及来源链接。另,不少答案得到寒小阳、管博士、张雨石、王赟、褚博士等七月在线名师审校。说明:本系列作为国外首个AI题库,首发于七月在线实验室公众号上:julyedulab,并部份更新......

过往记忆大数据

09-25

854

史上最全的大数据学习资源(Awesome Big Data)

为了使你们更好地学习交流,过往记忆大数据花了一个假期的时间把Awesome Big Data里逾 600 个大数据相关的调度、存储、计算、数据库以及可视化等介绍全部翻译了一遍,供你们学习交流。关系型数据库管理系统MySQL世界上最流行的开源数据库。PostgreSQL世界上最先进的开源数据库。Oracle Database- 对象关系数据库管理系统。Teradat......

weixin_34122548的博客

12-08

106

微服务核心构架梳理

在公司学习了接近一个月。 一个月内,从0开始开始接触分布式微服务构架,给了我不小的收获。今天,我来从头到尾梳理一下,有关微服务构架的核心内容(全是干货)。下文,你将见到业界主流微服务框架的核心原理,包括服务发觉,网关,配置中心,监控等组件,功能和构架原理的简单介绍。感谢阅读!...

GitChat

11-06

130

Python 数据科学入门

内容简介本书以 Python 语言讲解数据科学基础知识,涵盖了数据采集、清洗、存储、检索、转换、可视化、数据剖析(网络剖析)、统计和机器学习等内容。具体内容包括:数据科学的 Python 核心特点,文本数据、数据库、表格方式的数值数据、series 和 frame、网络数据的使用,数据的勾画,概率与统计,机器学习。 《Python 数据科学入门》面向研究生和本科生、数据科学教员、刚入门的数据科......

R先生三天不学习就四肢难过

10-27

6161

来来来,看看有没有适宜你的物联网操作系统

前言操作系统是物联网时代的战略制高点,今天 PC 和手机时代的操作系统霸主未必能在物联网时代延续霸业。操作系统产业的规律是,当垄断早已产生,后来者就很难颠覆,只有等待下一次产业浪潮。如今,一个全新的、充满想像空间的操作系统市场机会正在开启。 如此关键的产业环节必然是兵家必争之地。ARM、谷歌、微软、华为、阿里、海尔等国内外知名的 IT 企业纷纷推出物联网操作系统,整个产业呈现出群雄逐鹿的壮...

Python爬虫之用requests模块做一个简易的网页采集器

采集交流 • 优采云 发表了文章 • 0 个评论 • 372 次浏览 • 2020-08-15 05:41

其次我们介绍一下UA(User-Agent)检测和伪装。

1.UA测量:门户网站的服务器会检查对应恳求的载体身分标示,如果检查到恳求的载体的身分标示为某一浏览器,说明该恳求 是一个正常的恳求,但是,如果检查到恳求的载体身分标示不是基于某一款浏览器的,则表示该恳求为不正常的恳求(爬 虫),则服务器端就很有可能拒绝该次恳请。

2.UA伪装:让爬虫对应的恳求载体身分标示伪装成某一款浏览器

接下来就是我们实战的代码部份:

import requests

if __name__=='__main__':

#UA伪装:将对应的User-Agent封装到一个字典中

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3947.100 Safari/537.36'

}

url = 'https://www.sogou.com/web'

#动态的 需要对url携带的参数:封装到字典中

kw = input('enter a word:')

params = {

'query':kw

}

response = requests.get(url=url,params=params,headers=headers)

para_text = response.text

fileName = kw +'.html'

with open(fileName,'w',encoding='utf-8') as fp:

fp.write(para_text)

print(fileName,'保存成功!!')

简单介绍一下with open (文件储存位置,文件读取格式,文件编码格式) as fp:语法 查看全部

首先我们讲一下requests模块编码流程(4步):-指定URL -发起恳求Get或Post -获取响应数据 -存储

其次我们介绍一下UA(User-Agent)检测和伪装。

1.UA测量:门户网站的服务器会检查对应恳求的载体身分标示,如果检查到恳求的载体的身分标示为某一浏览器,说明该恳求 是一个正常的恳求,但是,如果检查到恳求的载体身分标示不是基于某一款浏览器的,则表示该恳求为不正常的恳求(爬 虫),则服务器端就很有可能拒绝该次恳请。

2.UA伪装:让爬虫对应的恳求载体身分标示伪装成某一款浏览器

接下来就是我们实战的代码部份:

import requests

if __name__=='__main__':

#UA伪装:将对应的User-Agent封装到一个字典中

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3947.100 Safari/537.36'

}

url = 'https://www.sogou.com/web'

#动态的 需要对url携带的参数:封装到字典中

kw = input('enter a word:')

params = {

'query':kw

}

response = requests.get(url=url,params=params,headers=headers)

para_text = response.text

fileName = kw +'.html'

with open(fileName,'w',encoding='utf-8') as fp:

fp.write(para_text)

print(fileName,'保存成功!!')

简单介绍一下with open (文件储存位置,文件读取格式,文件编码格式) as fp:语法

快速视频图象上取样

采集交流 • 优采云 发表了文章 • 0 个评论 • 279 次浏览 • 2020-08-14 22:49

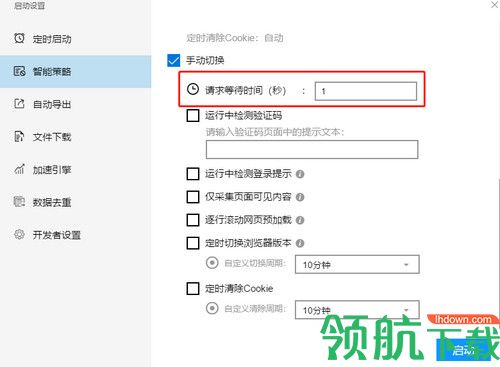

我们提出了一种简单而高效的上采样技巧。这种方式才能手动的提高视频图象的帧率,同时还能保持图象的重要结构信息。我们的方式主要优点在于一个反馈控制框架,这个框架才能从低码率图象准确地复原高分辨率图象,而不需要强加从其它样本中学习到的图象的局部结构约束信息。这促使我们的方式在图象质量上与通过大量取样学习得到的高质量图象是独立的。通常大量样本学习的算法,能够形成高质量的图象质量而没有可觉察到的难看的人工痕迹。我们的方式另外一个优点是可以很自然地扩充到视频的上采样中,同时,视频的暂态连续性才能手动的保持。最后,我们的算法运行的很快。我们通过不同的视频图象数据演示了我们的算法的有效性。

注:本文系我10年翻译的香港中文大学贾佳亚发表在SIGGRAPH ASIA 2008的文章,很多地方翻译的不好,敬请拜谢。

翻译稿请从这儿下载。

点击打开链接

原文下载地址:~leojia/projects/upsampling/index.html

他们的处理结果显示,上取样疗效相当不错,他们声称可以实时处理视频。但在没有GPU的情况下太慢太慢,在我的pc机上测试,对720p的图片放大2倍都要数10秒。

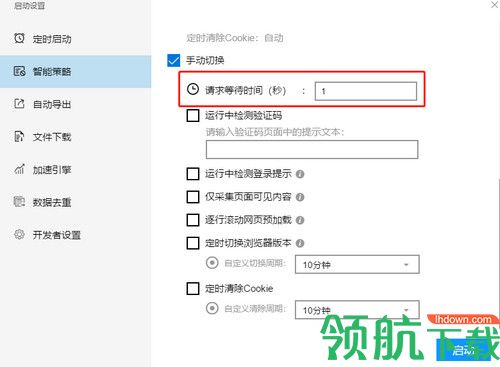

参照她们的思路,我用基于稀疏先验分布的反卷积算法实现了一下,实际疗效没有她们的好,但比Bicubic要好。而她们的处理疗效,比Bicubic显著的好出许多,他们的测试图如下:

查看全部

摘要

我们提出了一种简单而高效的上采样技巧。这种方式才能手动的提高视频图象的帧率,同时还能保持图象的重要结构信息。我们的方式主要优点在于一个反馈控制框架,这个框架才能从低码率图象准确地复原高分辨率图象,而不需要强加从其它样本中学习到的图象的局部结构约束信息。这促使我们的方式在图象质量上与通过大量取样学习得到的高质量图象是独立的。通常大量样本学习的算法,能够形成高质量的图象质量而没有可觉察到的难看的人工痕迹。我们的方式另外一个优点是可以很自然地扩充到视频的上采样中,同时,视频的暂态连续性才能手动的保持。最后,我们的算法运行的很快。我们通过不同的视频图象数据演示了我们的算法的有效性。

注:本文系我10年翻译的香港中文大学贾佳亚发表在SIGGRAPH ASIA 2008的文章,很多地方翻译的不好,敬请拜谢。

翻译稿请从这儿下载。

点击打开链接

原文下载地址:~leojia/projects/upsampling/index.html

他们的处理结果显示,上取样疗效相当不错,他们声称可以实时处理视频。但在没有GPU的情况下太慢太慢,在我的pc机上测试,对720p的图片放大2倍都要数10秒。

参照她们的思路,我用基于稀疏先验分布的反卷积算法实现了一下,实际疗效没有她们的好,但比Bicubic要好。而她们的处理疗效,比Bicubic显著的好出许多,他们的测试图如下:

多源数据采集与抽取系统需求尺寸说明书

采集交流 • 优采云 发表了文章 • 0 个评论 • 254 次浏览 • 2020-08-14 21:37

这里注重说明,以上功能的操作要依据具体角色而定,角色则根据权限组合而定。 2. 系统 介绍 该系统的设计和开发主要是为了满足乙方的要求和目的,完成包括多源数据采集模块、数据处理与抽取模块和系统检测与管理模块共 3 个主要功能模块组成的多源数据采集与抽取系统。本系统主要实现自动化与自动配置相结合,对多源数据(即行业类网站信息、政府公告类网站信息、新闻网页信息以及以微博为主的社交网站信息)进行自动化采集、清洗、处理和抽取,以及数据结构化入库,为美华公司业务系统提供所必要的数据服务。 上海美华系统有限公司作为现代物流信息增值服务体系的先驱者,根据当下的需求开发和设计企业多数据采集与抽取系统,为在现代化业务系统体系建设中能进一步处于领先的地位。故本系统的开发设计具有绝对的必要性和可行性。 3. 系统 应当遵守的标准或规范本系统符合 J2EE 开发规范。 4. 系统 范围 本系统总体上可分为三个模块:多源数据采集模块、数据处理与抽取模块和系统检测与管理模块。具体的来说,多源数据采集模块包括多线程采集器模块和采集配置模块;数据处理与抽取模块包括数据预处理模块和数据抽取模块;系统检测与管理模块包括系统检测模块和系统管理模块。

上述各个模块下又分为多个子模块,下面将详尽各个子模块的功能需求。 4.1 多源 数据采集模块 多源数据采集模块包括多线程采集器模块和采集配置模块。该模块针对多源数据进行采集器的设计以及采集配置。采用多线程设计模式,提高了采集的效率。下面进行两大模块的详尽介绍。 4.1.1 多线程 采集器 模块 多线程采集器模块是对不同采集对象的相关信息进行多线程采集的模块。该模块将采集对象大体分为 4 类,即行业类网站信息、政府公告类网站信息、新闻网页信息以及以微博为主的社交网站信息。针对不同的采集对象个性化订制了针对该对象的通用采集器,并设计了相应的数据更新策略。下面就其内容进行详尽地介绍。 4.1.1.1 行业类网站信息采集器 行业类网站中的文本信息专业性较强,多以结构化表格方式展示。采集器的设计注重对于表格信息的采集。 4.1.1.2 政府公告类网站信息采集器 政府公告类网站中的文本信息富含结构化表格和非结构化文本两种方式。采集器的设计须要对结构化表格数据和非结构化文本数据进行采集。 4.1.1.3 新闻网页类信息采集器 新闻网页类的文本信息具有较强的句型,多为自由文本类型。采集器的设计主要对自由文本型数据进行采集。

4.1.1.4 以微博为主的社交类网站信息采集器 社交网站多以非结构化的短文本信息为主,且图片信息相对来说比较多,同时信息的更新频度高。采集器的设计须要针对非结构化文本信息进行采集,以及调整采集的频率。 4.1.1.5 数据 信息 更新 采集 互联网上的信息处于不断更新的状态,该模块主要实现对早已获取到的数据对象进行定时更新重新采集,获取最新的业务数据信息。 4.1.2 采集 配置模块 采集配置模块是对采集过程所需的参数进行配置。包括采集对象的配置和通用的采集配置两个方面。 4.1.2.1 采集对象配置 采集对象的配置包括对须要采集的 URL 配置和须要采集的关键词的配置。 4.1.2.1.1 采集 URL 配置 分别搜集四大类网站的 URL 作为种子。根据页面在 web 上的分布特点,web上的主题页面容易成团出现。在页面采集过程中通过页面的超链接可以获得这种移动网页,因此同一个域名下的 URL 地址仅须要一个。通过更改种子 URL 参数来获得更多的 URL。 4.1.2.1.2 采集关键词配置 采集用户所需采集的信息的关键词,并通过多种搜索引擎对关键词进行搜索,最后对搜索结果进行采集。

各搜索引擎的能力和偏好不同,所以检索的结果也不一样,利用关键词在各搜索引擎进行检索,来获得比较全面,准确的检索结果。 4.1.2.2 通用采集配置 通用采集配置包括网页翻页配置,网页编码配置和采集深度配置三个部份。 4.1.2.2.1 网页翻页配置 网页翻页配置是针对网页信息多页显示的情况。根据网页信息的页数以及URL 参数的变化进行配置,确保网页信息采集的整体性。 4.1.2.2.2 网页编码配置 网页编码配置是针对网页信息编码格式不同的情况,进行网页编码格式的统一才能解决因为编码问题形成的乱码现象。 4.2 数据 处理与抽取模块 数据处理与抽取模块包括数据预处理模块和数据抽取模块。该模块主要针对采集获取到的多源数据信息进行预处理和业务数据信息的抽取和结构化。下面进行两大模块的详尽介绍。 4.2.1 数据 预处理 数据预处理模块主要针对采集获取到的多源数据信息进行预处理,包括数据格式的手动清洗、数据手动排重、数据手动分类等。 4.2.1.1 格式 清洗 主要实现对采集获取的目标网页内容进行初步筛选和整理,如乱码处理、HTML 标签处理等,然后将处理后的网页信息存入原创数据库,方便后期处理。

4.2.1.2 自动 排重 该模块主要实现对采集的海量数据进行冗余处理,包括在线手动排重、离线手动排重等多种策略。 4.2.1.3 自动 分类 主要实现对采集内容的分类,包括针对不同采集对象获取到的数据内容的初步分类,以及依照业务需求的对不同的数据类型进行自动分类,如表格、文本、图像类型等,使信息处理更具目的性。 4.2.2 数据 抽取 数据抽取模块主要针对预处理以后的数据信息进行低格抽取,包括网页正文抽取、表格处理、命名实体辨识、关联关系抽取以及特定内容抽取等。 4.2.2.1 网页正文抽取 主要实现对经过预处理(如字符编码问题、网页规范化问题、噪音信息过滤等)之后的目标网页进行模块化和特定正文的抽取,再对抽取的正文进行处理以达到业务数据库的需求,便于现有业务系统的直接使用以及数据挖掘业务。 4.2.2.2 表格处理 该模块主要实现对业务所需网页信息中的表格进行低格抽取,通过对目标表格内容进行定位、表格结构的辨识,实现对表格内容的整合和抽取。 4.2.2.3 命名实体辨识 主要实现借助自然语言处理技术(如基于规则和辞典的方式、基于统计的技巧、二者混和的方式等)对命名实体进行辨识,包括 3 大类(实体类、时间类和数字类)和 7 小类(人名、地名、机构名、时间、日期、货币和比率)的命名实体。

4.2.2.4 关系抽取 主要实现以模式构造、匹配、词典驱动、机器学习等多种算法模式进行关系抽取,包括同义关系、上下位关系等 4.2.2.5 特定内容 抽取 根据特定业务需求内容,实现基于用户手动配置抽取规则模式进行相应数据内容的抽取。 4.3 系统 监测与管理模块 系统检测与管理模块主要系统检测模块和系统管理模块。该模块主要实现对多源数据采集过程中的数据采集器进行监控和异常汇报,以及系统用户和用户权限管理的功能。 4.3.1 系统 监测模块 4.3.1.1 数据采集监控 该模块主要实现对多源数据采集器的监控,对采集数据量的半实时检测以及对采集目标对象数据更新和变化的侦测,方便及时对采集对象进行数据更新和处理。 4.3.1.2 异常监控 该模块主要实现对多源数据采集过程中数据采集器采集异常和线程异常的检测,及时发觉异常并通知用户做出应对策略,保证数据采集的正确性和完整性。 4.3.2 系统 管理模块 4.3.2.1 用户管理 该模块主要实现用户对系统的管理即用户可对抽取系统中的目标数据进行参数化配置,网页 URL 配置等。 4.3.2.2 权限管理 该模块主要实现对用户权限的设置,设置只有满足条件的管理员就能够登入进行管理。

5. 系统 功能性需求 5.1 系统所有模块 系统名称 模块 模块简介 多源数据采集与抽取系统 多源数据采集模块 主要实现多源数据进行采集器的设计以及采集配置 数据处理与抽取模块 主要实现采集获取到的多源数据信息进行预处理和业务数据信息的抽取和结构化 系统检测与管理模块 主要实现对多源数据采集过程中的数据采集器进行监控和异常汇报,以及系统用户和用户权限管理的功能。 5.2 多源数据 采集模块 模块名称 子模块 功能点 描述 多源数据采集模块 多线程采集器模块 行业类网站信息采集器 政府公告类网站信息采集器 新闻网页类信息采集器 以微博为主的社交类网站信息采集器 数据信息更新采集 采集配置模块 采集 URL 配置 采集关键词配置 网页翻页配置 网页编码配置 采集深度配置 5.3 数据处理 抽取模块 模块名称 子模块 功能点 描述 数据处理抽取模块 数据预处理 格式清洗 手动排重 自动分类 数据抽取 网页正文抽取 表格处理 命名实体辨识 关系抽取 特定内容抽取 5.4 系统检测 与 管理 模块 模块名称 子模块 功能点 描述 系统检测与管理模块 系统检测模块 数据采集监控 异常监控 系统管理模块 用户管理 权限管理录 附录 A :需求确认 需求承诺 需求文档 上海美华系统有限公司多源数据采集与抽取系统需求尺寸说明书,标识符, 0.2 ,王志宏,唐文武,徐永斌, 2015-01-22 顾客确认 签字,日期 项目总监确认 … 签字,日期 查看全部

华东理工大学多源数据采集与抽取系统 需求尺寸说明书 文件状态: [ ] 草稿 [ ] 正式发布 [√] 正在更改 文件标示: 当前版本: 0.2 文档类别: 需求尺寸说明书 完成日期: 2015.01.22 作 者: 王志宏,唐文武,徐永斌 受控状态: 受控修订历史记录 日期 版本 说明 作者 2014-12-12 0.1 创建需求尺寸说明书 王志宏,唐文武,徐永斌 2015-01-22 0.2 修改需求尺寸说明书 王志宏,唐文武,徐永斌1. 文档介绍 本文档是对项目的委托单位,上海美华系统有限公司(以下简称为乙方)和项目的开发单位,华东理工大学(以下简称为甲方)关于多源数据采集与抽取系统开发内容的进一步说明。目的是在确定范围内进一步明晰甲乙双方在软件开发过程中的权力和责任。 1.1 文档 目的 1. 作为丙方初验甲方开发产品的根据,并约束乙方不得随便变更需求内容。 2. 作为甲方软件开发的出发点,并约束甲方开发的软件产品确切完整地符合需求内容。 1.2 文档 范围 本文档对乙方多源数据采集与抽取系统进行需求尺寸说明。该系统主要包括多源数据采集模块、数据处理与抽取模块和系统检测与管理模块 3 个主要功能模块。

这里注重说明,以上功能的操作要依据具体角色而定,角色则根据权限组合而定。 2. 系统 介绍 该系统的设计和开发主要是为了满足乙方的要求和目的,完成包括多源数据采集模块、数据处理与抽取模块和系统检测与管理模块共 3 个主要功能模块组成的多源数据采集与抽取系统。本系统主要实现自动化与自动配置相结合,对多源数据(即行业类网站信息、政府公告类网站信息、新闻网页信息以及以微博为主的社交网站信息)进行自动化采集、清洗、处理和抽取,以及数据结构化入库,为美华公司业务系统提供所必要的数据服务。 上海美华系统有限公司作为现代物流信息增值服务体系的先驱者,根据当下的需求开发和设计企业多数据采集与抽取系统,为在现代化业务系统体系建设中能进一步处于领先的地位。故本系统的开发设计具有绝对的必要性和可行性。 3. 系统 应当遵守的标准或规范本系统符合 J2EE 开发规范。 4. 系统 范围 本系统总体上可分为三个模块:多源数据采集模块、数据处理与抽取模块和系统检测与管理模块。具体的来说,多源数据采集模块包括多线程采集器模块和采集配置模块;数据处理与抽取模块包括数据预处理模块和数据抽取模块;系统检测与管理模块包括系统检测模块和系统管理模块。

上述各个模块下又分为多个子模块,下面将详尽各个子模块的功能需求。 4.1 多源 数据采集模块 多源数据采集模块包括多线程采集器模块和采集配置模块。该模块针对多源数据进行采集器的设计以及采集配置。采用多线程设计模式,提高了采集的效率。下面进行两大模块的详尽介绍。 4.1.1 多线程 采集器 模块 多线程采集器模块是对不同采集对象的相关信息进行多线程采集的模块。该模块将采集对象大体分为 4 类,即行业类网站信息、政府公告类网站信息、新闻网页信息以及以微博为主的社交网站信息。针对不同的采集对象个性化订制了针对该对象的通用采集器,并设计了相应的数据更新策略。下面就其内容进行详尽地介绍。 4.1.1.1 行业类网站信息采集器 行业类网站中的文本信息专业性较强,多以结构化表格方式展示。采集器的设计注重对于表格信息的采集。 4.1.1.2 政府公告类网站信息采集器 政府公告类网站中的文本信息富含结构化表格和非结构化文本两种方式。采集器的设计须要对结构化表格数据和非结构化文本数据进行采集。 4.1.1.3 新闻网页类信息采集器 新闻网页类的文本信息具有较强的句型,多为自由文本类型。采集器的设计主要对自由文本型数据进行采集。

4.1.1.4 以微博为主的社交类网站信息采集器 社交网站多以非结构化的短文本信息为主,且图片信息相对来说比较多,同时信息的更新频度高。采集器的设计须要针对非结构化文本信息进行采集,以及调整采集的频率。 4.1.1.5 数据 信息 更新 采集 互联网上的信息处于不断更新的状态,该模块主要实现对早已获取到的数据对象进行定时更新重新采集,获取最新的业务数据信息。 4.1.2 采集 配置模块 采集配置模块是对采集过程所需的参数进行配置。包括采集对象的配置和通用的采集配置两个方面。 4.1.2.1 采集对象配置 采集对象的配置包括对须要采集的 URL 配置和须要采集的关键词的配置。 4.1.2.1.1 采集 URL 配置 分别搜集四大类网站的 URL 作为种子。根据页面在 web 上的分布特点,web上的主题页面容易成团出现。在页面采集过程中通过页面的超链接可以获得这种移动网页,因此同一个域名下的 URL 地址仅须要一个。通过更改种子 URL 参数来获得更多的 URL。 4.1.2.1.2 采集关键词配置 采集用户所需采集的信息的关键词,并通过多种搜索引擎对关键词进行搜索,最后对搜索结果进行采集。

各搜索引擎的能力和偏好不同,所以检索的结果也不一样,利用关键词在各搜索引擎进行检索,来获得比较全面,准确的检索结果。 4.1.2.2 通用采集配置 通用采集配置包括网页翻页配置,网页编码配置和采集深度配置三个部份。 4.1.2.2.1 网页翻页配置 网页翻页配置是针对网页信息多页显示的情况。根据网页信息的页数以及URL 参数的变化进行配置,确保网页信息采集的整体性。 4.1.2.2.2 网页编码配置 网页编码配置是针对网页信息编码格式不同的情况,进行网页编码格式的统一才能解决因为编码问题形成的乱码现象。 4.2 数据 处理与抽取模块 数据处理与抽取模块包括数据预处理模块和数据抽取模块。该模块主要针对采集获取到的多源数据信息进行预处理和业务数据信息的抽取和结构化。下面进行两大模块的详尽介绍。 4.2.1 数据 预处理 数据预处理模块主要针对采集获取到的多源数据信息进行预处理,包括数据格式的手动清洗、数据手动排重、数据手动分类等。 4.2.1.1 格式 清洗 主要实现对采集获取的目标网页内容进行初步筛选和整理,如乱码处理、HTML 标签处理等,然后将处理后的网页信息存入原创数据库,方便后期处理。

4.2.1.2 自动 排重 该模块主要实现对采集的海量数据进行冗余处理,包括在线手动排重、离线手动排重等多种策略。 4.2.1.3 自动 分类 主要实现对采集内容的分类,包括针对不同采集对象获取到的数据内容的初步分类,以及依照业务需求的对不同的数据类型进行自动分类,如表格、文本、图像类型等,使信息处理更具目的性。 4.2.2 数据 抽取 数据抽取模块主要针对预处理以后的数据信息进行低格抽取,包括网页正文抽取、表格处理、命名实体辨识、关联关系抽取以及特定内容抽取等。 4.2.2.1 网页正文抽取 主要实现对经过预处理(如字符编码问题、网页规范化问题、噪音信息过滤等)之后的目标网页进行模块化和特定正文的抽取,再对抽取的正文进行处理以达到业务数据库的需求,便于现有业务系统的直接使用以及数据挖掘业务。 4.2.2.2 表格处理 该模块主要实现对业务所需网页信息中的表格进行低格抽取,通过对目标表格内容进行定位、表格结构的辨识,实现对表格内容的整合和抽取。 4.2.2.3 命名实体辨识 主要实现借助自然语言处理技术(如基于规则和辞典的方式、基于统计的技巧、二者混和的方式等)对命名实体进行辨识,包括 3 大类(实体类、时间类和数字类)和 7 小类(人名、地名、机构名、时间、日期、货币和比率)的命名实体。

4.2.2.4 关系抽取 主要实现以模式构造、匹配、词典驱动、机器学习等多种算法模式进行关系抽取,包括同义关系、上下位关系等 4.2.2.5 特定内容 抽取 根据特定业务需求内容,实现基于用户手动配置抽取规则模式进行相应数据内容的抽取。 4.3 系统 监测与管理模块 系统检测与管理模块主要系统检测模块和系统管理模块。该模块主要实现对多源数据采集过程中的数据采集器进行监控和异常汇报,以及系统用户和用户权限管理的功能。 4.3.1 系统 监测模块 4.3.1.1 数据采集监控 该模块主要实现对多源数据采集器的监控,对采集数据量的半实时检测以及对采集目标对象数据更新和变化的侦测,方便及时对采集对象进行数据更新和处理。 4.3.1.2 异常监控 该模块主要实现对多源数据采集过程中数据采集器采集异常和线程异常的检测,及时发觉异常并通知用户做出应对策略,保证数据采集的正确性和完整性。 4.3.2 系统 管理模块 4.3.2.1 用户管理 该模块主要实现用户对系统的管理即用户可对抽取系统中的目标数据进行参数化配置,网页 URL 配置等。 4.3.2.2 权限管理 该模块主要实现对用户权限的设置,设置只有满足条件的管理员就能够登入进行管理。

5. 系统 功能性需求 5.1 系统所有模块 系统名称 模块 模块简介 多源数据采集与抽取系统 多源数据采集模块 主要实现多源数据进行采集器的设计以及采集配置 数据处理与抽取模块 主要实现采集获取到的多源数据信息进行预处理和业务数据信息的抽取和结构化 系统检测与管理模块 主要实现对多源数据采集过程中的数据采集器进行监控和异常汇报,以及系统用户和用户权限管理的功能。 5.2 多源数据 采集模块 模块名称 子模块 功能点 描述 多源数据采集模块 多线程采集器模块 行业类网站信息采集器 政府公告类网站信息采集器 新闻网页类信息采集器 以微博为主的社交类网站信息采集器 数据信息更新采集 采集配置模块 采集 URL 配置 采集关键词配置 网页翻页配置 网页编码配置 采集深度配置 5.3 数据处理 抽取模块 模块名称 子模块 功能点 描述 数据处理抽取模块 数据预处理 格式清洗 手动排重 自动分类 数据抽取 网页正文抽取 表格处理 命名实体辨识 关系抽取 特定内容抽取 5.4 系统检测 与 管理 模块 模块名称 子模块 功能点 描述 系统检测与管理模块 系统检测模块 数据采集监控 异常监控 系统管理模块 用户管理 权限管理录 附录 A :需求确认 需求承诺 需求文档 上海美华系统有限公司多源数据采集与抽取系统需求尺寸说明书,标识符, 0.2 ,王志宏,唐文武,徐永斌, 2015-01-22 顾客确认 签字,日期 项目总监确认 … 签字,日期

制作SupeSite采集器

采集交流 • 优采云 发表了文章 • 0 个评论 • 301 次浏览 • 2020-08-14 12:26

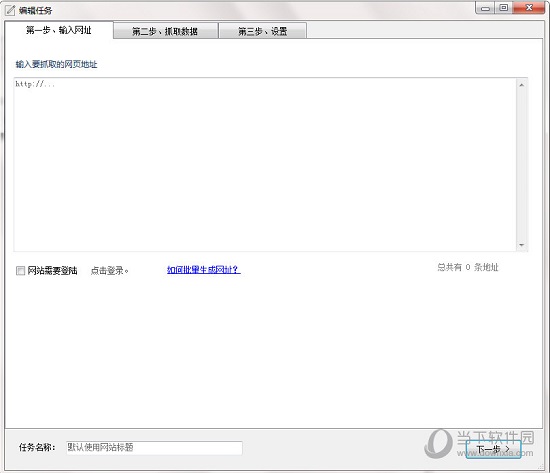

1、确定您要采集哪个页面的新闻,将那些页面的地址填入到“索引页面url地址(图4和5)”;

2、确定在那些页面您要采集的内容区域,因为不是一个网页所有的内容都要采集回来,而是采集一个网页的一部分内容,所以您必须告诉程序您要采集的区域,也就是“列表区域辨识规则”;(图4和5)

3、第2步确定区域以后,还要告诉程序您要采集的文章链接,也就是“文章链接url辨识规则”。(图4和5)

4、现在早已确定了大的采集框架,接下来要告诉程序在一个文章页面,文章的标题,文章的来源和作者分别是哪些。然后就是一篇文章内容的范围,也就是说一个文章页面内,真正您须要采集的范围,就是“文章内容辨识规则”。最后设置分页的区域和分页的链接地址。(图6)。

5、以上4个步骤早已确定了采集的范围,如果您须要过滤标题和内容,请按照您的要求设置“内容页面整理设置”。

以上几个步骤确定范围都是通过查看页面源码,进行设置的,截取的方式须要一些经验,练习2--3次就可以体悟到了。

接下来介绍采集器的基本原理和步骤:

第一:打开后台的采集器,点击“添加新机器人”。(图1)

第二:填写基本设置:(图2)

这里须要非常强调的有两个地方:单次采集个数和采集页面编码。单次采集个数尽量设置较小的数字,以免超时。采集页面编码是您采 集网页的编码,并不是您站点的编码。这里谨记!!

查看采集页面编码的方式:点击网页背部的“查看”,然后点击“源文件”,然后找到类似“” ,charset前面的就是这儿须要填写的“采集页面编码”。(图3)

第三:列表页面采集设置:(图4)和(图5)

这里设置的是采集页面的url地址,采集内容的区域范围,采集文章标题的url地址。

采集页面的url地址有两种设置方式:手动输入(图4)和手动下降(图5)。手动输入须要您自己将所需采集的地址逐行输入。自动下降 只需填入采集页面的地址和页面页脚。详见图5。用[page]代替分页变量。

采集内容的范围用[list]代替,采集文章的标题用[url]代替。

第四:内容页面采集设置:(图6)

这里须要设置的采集规则有:文章标题,文章来源(选填),文章作者(选填),文章内容,分页设置(选填)。

文章标题用[subject]代替,文章来源用[from]代替,文章作者用[author]代替,文章内容用[message]代替,分页区域用[pagearea]代 替,分页链接用[page]代替。

之后的过滤设置可以按照您的须要和采集页面的具体情况进行填写。

设置完毕以后点击递交,然后点击“开始采集”(图7),图8是采集的过程,采集完毕以后点击“查看结果”(图9),如果您的采集规 则正确,可以得到图10的页面,最后将采集的内容导出资讯。这里说明一点:采集的内容只能够导出资讯这个频道。

查看全部

首先简单说一下制做采集器的基本原理和思路:

1、确定您要采集哪个页面的新闻,将那些页面的地址填入到“索引页面url地址(图4和5)”;

2、确定在那些页面您要采集的内容区域,因为不是一个网页所有的内容都要采集回来,而是采集一个网页的一部分内容,所以您必须告诉程序您要采集的区域,也就是“列表区域辨识规则”;(图4和5)

3、第2步确定区域以后,还要告诉程序您要采集的文章链接,也就是“文章链接url辨识规则”。(图4和5)

4、现在早已确定了大的采集框架,接下来要告诉程序在一个文章页面,文章的标题,文章的来源和作者分别是哪些。然后就是一篇文章内容的范围,也就是说一个文章页面内,真正您须要采集的范围,就是“文章内容辨识规则”。最后设置分页的区域和分页的链接地址。(图6)。

5、以上4个步骤早已确定了采集的范围,如果您须要过滤标题和内容,请按照您的要求设置“内容页面整理设置”。

以上几个步骤确定范围都是通过查看页面源码,进行设置的,截取的方式须要一些经验,练习2--3次就可以体悟到了。

接下来介绍采集器的基本原理和步骤:

第一:打开后台的采集器,点击“添加新机器人”。(图1)

第二:填写基本设置:(图2)

这里须要非常强调的有两个地方:单次采集个数和采集页面编码。单次采集个数尽量设置较小的数字,以免超时。采集页面编码是您采 集网页的编码,并不是您站点的编码。这里谨记!!

查看采集页面编码的方式:点击网页背部的“查看”,然后点击“源文件”,然后找到类似“” ,charset前面的就是这儿须要填写的“采集页面编码”。(图3)

第三:列表页面采集设置:(图4)和(图5)

这里设置的是采集页面的url地址,采集内容的区域范围,采集文章标题的url地址。

采集页面的url地址有两种设置方式:手动输入(图4)和手动下降(图5)。手动输入须要您自己将所需采集的地址逐行输入。自动下降 只需填入采集页面的地址和页面页脚。详见图5。用[page]代替分页变量。

采集内容的范围用[list]代替,采集文章的标题用[url]代替。

第四:内容页面采集设置:(图6)

这里须要设置的采集规则有:文章标题,文章来源(选填),文章作者(选填),文章内容,分页设置(选填)。

文章标题用[subject]代替,文章来源用[from]代替,文章作者用[author]代替,文章内容用[message]代替,分页区域用[pagearea]代 替,分页链接用[page]代替。

之后的过滤设置可以按照您的须要和采集页面的具体情况进行填写。

设置完毕以后点击递交,然后点击“开始采集”(图7),图8是采集的过程,采集完毕以后点击“查看结果”(图9),如果您的采集规 则正确,可以得到图10的页面,最后将采集的内容导出资讯。这里说明一点:采集的内容只能够导出资讯这个频道。

哈尔滨网站优化:网站SEO采集利用python洗稿

采集交流 • 优采云 发表了文章 • 0 个评论 • 536 次浏览 • 2020-08-13 09:37

1,tr算法提取摘要再人工重组新的文章。

正好明天西安网站优化发觉了python中的textrank4zh库,依赖于jieba、numpy和networkx库,可以通过tr算法进行文章的摘要提取。然后按照摘要再人工洗稿,整合成一篇全新的文章。

测试一篇蚂蜂窝里面的问答,蚂蜂窝问答下边是有很多个答主的内容,通过python爬取所有内容,然后再利用tr算法提取摘要,根据摘要进行重组出一篇新的文章。这样基本上可以成功躲避飓风算法。

先安装依赖库,然后再利用tr4进行摘要提取。

2,利用google翻译双向翻译洗稿

之前西安网站优化有接触一个所谓人工智能洗稿的网站优采云,说的是借助NLP算法进行洗稿,本来我以为洗稿只有同义词替换这个办法。

后来研究了一下优采云,我首先认为这个绝对不是借助哪些所谓的NLP算法来洗稿,研究了一下发觉可能是借助google翻译进行单向翻译,就是先英文翻译日文,然后再拿翻译下来的中文再翻译成英文。

自己也开发了一个这样的伪原创工具,发现虽然并不好用。如果不仔细读,这样单向翻译下来的文章还能读,但是仔细读的话。其实句型习惯还有用词根本不确切,甚至有些情况还改变了这句话原有的语义。

哈尔滨网站优化仍然在想如何能正确高效的处理seo中,采集的文章怎么去伪原创和洗稿。如果是人工操作的话,那就太麻烦了。采集下来的文章不进行伪原创又担心被飓风算法命中。

1,tr算法提取摘要再人工重组新的文章。哈尔滨网站优化:网站SEO采集利用python洗稿

报价与咨询请点击拨通电话: 查看全部

哈尔滨网站优化仍然在想如何能正确高效的处理seo中,采集的文章怎么去伪原创和洗稿。如果是人工操作的话,那就太麻烦了。采集下来的文章不进行伪原创又担心被飓风算法命中。

1,tr算法提取摘要再人工重组新的文章。

正好明天西安网站优化发觉了python中的textrank4zh库,依赖于jieba、numpy和networkx库,可以通过tr算法进行文章的摘要提取。然后按照摘要再人工洗稿,整合成一篇全新的文章。

测试一篇蚂蜂窝里面的问答,蚂蜂窝问答下边是有很多个答主的内容,通过python爬取所有内容,然后再利用tr算法提取摘要,根据摘要进行重组出一篇新的文章。这样基本上可以成功躲避飓风算法。

先安装依赖库,然后再利用tr4进行摘要提取。

2,利用google翻译双向翻译洗稿

之前西安网站优化有接触一个所谓人工智能洗稿的网站优采云,说的是借助NLP算法进行洗稿,本来我以为洗稿只有同义词替换这个办法。

后来研究了一下优采云,我首先认为这个绝对不是借助哪些所谓的NLP算法来洗稿,研究了一下发觉可能是借助google翻译进行单向翻译,就是先英文翻译日文,然后再拿翻译下来的中文再翻译成英文。

自己也开发了一个这样的伪原创工具,发现虽然并不好用。如果不仔细读,这样单向翻译下来的文章还能读,但是仔细读的话。其实句型习惯还有用词根本不确切,甚至有些情况还改变了这句话原有的语义。

哈尔滨网站优化仍然在想如何能正确高效的处理seo中,采集的文章怎么去伪原创和洗稿。如果是人工操作的话,那就太麻烦了。采集下来的文章不进行伪原创又担心被飓风算法命中。

1,tr算法提取摘要再人工重组新的文章。哈尔滨网站优化:网站SEO采集利用python洗稿

报价与咨询请点击拨通电话:

公众号文章采集器特性有什么?采集器如何采集微信文章?

采集交流 • 优采云 发表了文章 • 0 个评论 • 294 次浏览 • 2020-08-13 05:46

大家在编撰微信公众号上面的文章的时侯,通常还会采集下其他的文章作为参考,这样就可以使用公众号文章采集器了,那么公众号文章采集器特性有什么?采集器如何采集微信文章?今天拓途数据就来介绍下。

公众号文章采集器

公众号文章采集器特性和功能

云采集

5000台云服务器,24*7高效稳定采集,结合API可无缝对接内部系统,定期同步爬取数据。

智能采集

提供多种网页采集策略与配套资源,帮助整个采集过程实现数据的完整性与稳定性。

全网适用

眼见即可采,不管是文字图片,还是帖吧峰会,支持所有业务渠道的爬虫,满足各类采集需求。

海量模板

内置数百个网站数据源,全面覆盖多个行业,只需简单设置,就可快速确切获取数据。

简单易用

无需再学爬虫编程技术,简单三步就可以轻松抓取网页数据,支持多种格式一键导入,快速导出数据库。

稳定高效

分布式云集群服务器和多用户协作管理平台的支撑,可灵活调度任务,顺利爬取海量数据。

可视化点击,简单上手

流程图模式:只需按照软件提示在页面中进行点击操作,完全符合人为浏览网页的思维方法,简单几步即可生成复杂的采集规则,结合智能辨识算法,任何网页的数据都能轻松采集。

可模拟操作: 输入文本、点击、移动滑鼠、下拉框、滚动页面、等待加载、循环操作和判别条件等。

支持多种数据导入方法

采集结果可以导入到本地,支持TXT、EXCEL、CSV和HTML文件格式,也可以直接发布到数据库(MySQL、MongoDB、SQL Server、PostgreSQL)供您使用。

功能强悍,提供企业级服务

优采云采集器提供丰富的采集功能,无论是采集稳定性或是采集效率,都还能满足个人、团队和企业级采集需求。

丰富的功能: 定时采集,自动导入,文件下载,加速引擎,按组启动和导入,Webhook,RESTful API,智能辨识SKU和电商大图等。

公众号文章采集器是怎样采集微信文章的?

A:关键词批量搜索采集

可以批量粘贴关键词进行搜索,选择采集内容日期,可以对标题及内容伪原创,以及辨识文章是否原创,支持文章一件分发到网站

对于有些做SEO的还降低了在标题或则内容随机插入长尾词,你可以去下载有指数的长尾词,导入进去做流量

B:指定公众号采集

你可以通过公众号排行榜或则自己搜索你行业的公众号,然后粘贴进去,其他功能与第一项相同,依然可用,比如你是做教育或则财税的企业,以及专业SEO,都可以通过此功能在或则优质的原创文章获得流量

C:热门行业采集

按行业分类采集,其功能与第一项一样

D:自动采集发布

自动采集发布仍然是批量搜索关键词以及其他功能如图不表,重点是有一个用处,不同的关键词或则微信号采集可以选择全选,他会按次序继续采集,举个反例:你有10个栏目,那么每位栏目你可以设置一个跟栏目相关词采集入库,当第一个采集完成,他会手动进行第二个栏目采集入库。

公众号文章采集器

如何采集其他微信公众号里的文章到微信编辑器?

方法/步骤

一、获取文章链接

电脑端用户可直接全选复制浏览器地址栏中的文章链接。

手机端用户可点击右上角菜单按键,选择复制链接,将该链接发送到笔记本上。

二、点击采集文章按钮

小蚂蚁编辑器采集文章功能入口有两个:

1. 编辑菜单右上角的采集文章按钮;

2. 右侧功能按键顶部的采集文章按钮

三、粘贴文章链接点击采集

采集完成后即可对文章进行编辑与更改。

通过以上的内容,我们早已了解了公众号文章采集器的特性和功能了,可见,公众号文章采集器的功能是十分强悍的,而且也是十分全面的。 查看全部

大家在编撰微信公众号上面的文章的时侯,通常还会采集下其他的文章作为参考,这样就可以使用公众号文章采集器了,那么公众号文章采集器特性有什么?采集器如何采集微信文章?今天拓途数据就来介绍下。

公众号文章采集器

公众号文章采集器特性和功能

云采集

5000台云服务器,24*7高效稳定采集,结合API可无缝对接内部系统,定期同步爬取数据。

智能采集

提供多种网页采集策略与配套资源,帮助整个采集过程实现数据的完整性与稳定性。

全网适用

眼见即可采,不管是文字图片,还是帖吧峰会,支持所有业务渠道的爬虫,满足各类采集需求。

海量模板

内置数百个网站数据源,全面覆盖多个行业,只需简单设置,就可快速确切获取数据。

简单易用

无需再学爬虫编程技术,简单三步就可以轻松抓取网页数据,支持多种格式一键导入,快速导出数据库。

稳定高效

分布式云集群服务器和多用户协作管理平台的支撑,可灵活调度任务,顺利爬取海量数据。

可视化点击,简单上手

流程图模式:只需按照软件提示在页面中进行点击操作,完全符合人为浏览网页的思维方法,简单几步即可生成复杂的采集规则,结合智能辨识算法,任何网页的数据都能轻松采集。

可模拟操作: 输入文本、点击、移动滑鼠、下拉框、滚动页面、等待加载、循环操作和判别条件等。

支持多种数据导入方法

采集结果可以导入到本地,支持TXT、EXCEL、CSV和HTML文件格式,也可以直接发布到数据库(MySQL、MongoDB、SQL Server、PostgreSQL)供您使用。

功能强悍,提供企业级服务

优采云采集器提供丰富的采集功能,无论是采集稳定性或是采集效率,都还能满足个人、团队和企业级采集需求。

丰富的功能: 定时采集,自动导入,文件下载,加速引擎,按组启动和导入,Webhook,RESTful API,智能辨识SKU和电商大图等。

公众号文章采集器是怎样采集微信文章的?

A:关键词批量搜索采集

可以批量粘贴关键词进行搜索,选择采集内容日期,可以对标题及内容伪原创,以及辨识文章是否原创,支持文章一件分发到网站

对于有些做SEO的还降低了在标题或则内容随机插入长尾词,你可以去下载有指数的长尾词,导入进去做流量

B:指定公众号采集

你可以通过公众号排行榜或则自己搜索你行业的公众号,然后粘贴进去,其他功能与第一项相同,依然可用,比如你是做教育或则财税的企业,以及专业SEO,都可以通过此功能在或则优质的原创文章获得流量

C:热门行业采集

按行业分类采集,其功能与第一项一样

D:自动采集发布

自动采集发布仍然是批量搜索关键词以及其他功能如图不表,重点是有一个用处,不同的关键词或则微信号采集可以选择全选,他会按次序继续采集,举个反例:你有10个栏目,那么每位栏目你可以设置一个跟栏目相关词采集入库,当第一个采集完成,他会手动进行第二个栏目采集入库。

公众号文章采集器

如何采集其他微信公众号里的文章到微信编辑器?

方法/步骤

一、获取文章链接

电脑端用户可直接全选复制浏览器地址栏中的文章链接。

手机端用户可点击右上角菜单按键,选择复制链接,将该链接发送到笔记本上。

二、点击采集文章按钮

小蚂蚁编辑器采集文章功能入口有两个:

1. 编辑菜单右上角的采集文章按钮;

2. 右侧功能按键顶部的采集文章按钮

三、粘贴文章链接点击采集

采集完成后即可对文章进行编辑与更改。

通过以上的内容,我们早已了解了公众号文章采集器的特性和功能了,可见,公众号文章采集器的功能是十分强悍的,而且也是十分全面的。

老网站为什么不收录?参考如下你是否也中招了

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2020-08-13 00:55

如果你的网站近段时间内有大规模的更新,突然停止收录是正常的,百度要重新对你的网站进行衡量,如果是这样,你只要做好站内文章的更新和稳定的外链,制定一个稳定的网站内容建设方案,等待百度反应过来即可。

06、文章出现敏感词

现在百度早已加强人工对文章收录的初审,当网路那里出现敏感词,百度内部的相关人员都会去进行人工初审,甚至文章出现敏感词,就直接被搜索引擎抵触,没有进行收录,甚至会影响网站的权重。

07、高质量外链过少

即使你的网站已经营运了一两年了,可网站的文章页面的外链假如极少,或者没有,那么也会导致文章没有被收录,或者收录太慢。

这主要的诱因可能就是网站的外链广泛度很低,链接质量度很低,搜索引擎无法找到你,这时要考虑把网站登录到著名分类目录,或多做一些高质量链接。

08、网站的友情链接影响收录

对于友情链接的交换我们一定也要慎重,我们应对我们的友链每周进行统计,然后进行数据观察,对方的外链,对方排行,收录以及是否降权、404等问题

如果你的友链被牵扯降权或则你的友链降权这么抱歉你也会被一起遭到惩罚,在惩罚期间内你同样会出现快照慢,收录少的情况,所以做好友链检测也每周例行的工作。

如果搜索引擎爬去到你的友情链接的网站,搜索引擎蜘蛛也可以通过对方链接你的缘由,从而爬去到你的网站,收录你的页面。

09、搜索引擎蜘蛛爬取的频繁度

一个网站收录的快与否,根本诱因就是搜索引擎蜘蛛爬取的频繁度,这个对网站文章收录特别的最重要。

其实很简单,做站时间长的站长都应当晓得,当网站的更新越频繁,那么吸引的蜘蛛也就越多,其实我们即使是做外链也都是有吸引蜘蛛的目的,当网站每天都有在更新的时侯,蜘蛛对于你的网站爬取的频度都会增强,而蜘蛛爬取的频度越高,你的文章被收录的也就越多。

10、网站优化过度

优化过度说的最显著的莫过于关键词拼凑,好比一个人喝保健品,吃多了也会成为毒药,因为你没法消化,肯定会导致体内营养短缺,优化过度还存在于站内链接过多,已经过度造成页面权重分散,而最终你的首页权重平平,会出现收录减少也是很正常的事情,另外,网站挂黑链,网站做多重镜像,有的时侯甚至为了讨好用户体验,加了好多图片,很多FLASH,压根没哪些收录价值可言,所以对于这一点,搜索引擎也不会抓取收录你的网站

11、网站被降权

如果文章质量过关,那么还是长时间不被收录,只有一个答案,唯一的解释就是,网站被降权了,请复查网站,是否有被降权的迹象。

这是文章不收录最常见的一种缘由,网站降权后,网站有可能会暂停收录,因为搜索引擎对这个网站不信任,重点对他初审。

12、网站改版

网站已经营运了一两年以后,感觉现今的模板不够好,于是就对网站进行全面改版,也会导致网站文章短暂的不收录。

对于网站改版后,网站内容出现不收录,很大可能是因为网站的程序换掉了,并且链接都发生了改变,这种大变动的改变必然会导致网站出现快照不更新、内容不被收录,网站排名全线增长的情况。

搜索引擎是以收录的页面来辨识网站的,如果忽然发觉你的网站变了一个样,搜索引擎就得对你的网站重新认识,从而把你的网站拉入考核期,看你的网站是否存在异常。

13、网站空间或服务器忽然不稳定

当搜索引擎通过其他外链达到网站的时侯,发现网站访问不了,那么他都会尽兴而回。这似乎一个老朋友想到你家作客,他去到家门口的时侯,他敲了半天的门都没有人你都没有下来迎接他,这时候不要说不收录了,没有降权就早已很不错了。

所以在网站建设前期,一定要选一个稳定的网站空间,这一点很重要。关于网站空间不稳定有什么影响,下一篇和你们详尽的说明。

14、搜索引擎算法更新

另外,还有一种缘由就是由于搜索引擎新算法的更新,有时候,因为搜索引擎新算法、新规则的颁布,我们的网站又违反了新算法的规则,也会导致网站短期的不收录,或者直接被降权。

对于这些缘由造成的不收录文章,只要我们依照搜索引擎新算法的规则,将网站完善或改进一下,很快就恢复了。

青梅SEO教学总结:关于老站不收录的缘由总共就这几点,根据自己网站的实际情况去结合,你的网站为什么不收录,然后去解决,相信你的网站会很快收录的。搜索引擎也是越来越智能化,所以我们要做的就是符合他的喜好度,来满足他,然后还要符合用户的喜欢,去统筹布局。 查看全部

05、网站近期有大规模的文章更新

如果你的网站近段时间内有大规模的更新,突然停止收录是正常的,百度要重新对你的网站进行衡量,如果是这样,你只要做好站内文章的更新和稳定的外链,制定一个稳定的网站内容建设方案,等待百度反应过来即可。

06、文章出现敏感词

现在百度早已加强人工对文章收录的初审,当网路那里出现敏感词,百度内部的相关人员都会去进行人工初审,甚至文章出现敏感词,就直接被搜索引擎抵触,没有进行收录,甚至会影响网站的权重。

07、高质量外链过少

即使你的网站已经营运了一两年了,可网站的文章页面的外链假如极少,或者没有,那么也会导致文章没有被收录,或者收录太慢。

这主要的诱因可能就是网站的外链广泛度很低,链接质量度很低,搜索引擎无法找到你,这时要考虑把网站登录到著名分类目录,或多做一些高质量链接。

08、网站的友情链接影响收录

对于友情链接的交换我们一定也要慎重,我们应对我们的友链每周进行统计,然后进行数据观察,对方的外链,对方排行,收录以及是否降权、404等问题

如果你的友链被牵扯降权或则你的友链降权这么抱歉你也会被一起遭到惩罚,在惩罚期间内你同样会出现快照慢,收录少的情况,所以做好友链检测也每周例行的工作。

如果搜索引擎爬去到你的友情链接的网站,搜索引擎蜘蛛也可以通过对方链接你的缘由,从而爬去到你的网站,收录你的页面。

09、搜索引擎蜘蛛爬取的频繁度

一个网站收录的快与否,根本诱因就是搜索引擎蜘蛛爬取的频繁度,这个对网站文章收录特别的最重要。

其实很简单,做站时间长的站长都应当晓得,当网站的更新越频繁,那么吸引的蜘蛛也就越多,其实我们即使是做外链也都是有吸引蜘蛛的目的,当网站每天都有在更新的时侯,蜘蛛对于你的网站爬取的频度都会增强,而蜘蛛爬取的频度越高,你的文章被收录的也就越多。

10、网站优化过度

优化过度说的最显著的莫过于关键词拼凑,好比一个人喝保健品,吃多了也会成为毒药,因为你没法消化,肯定会导致体内营养短缺,优化过度还存在于站内链接过多,已经过度造成页面权重分散,而最终你的首页权重平平,会出现收录减少也是很正常的事情,另外,网站挂黑链,网站做多重镜像,有的时侯甚至为了讨好用户体验,加了好多图片,很多FLASH,压根没哪些收录价值可言,所以对于这一点,搜索引擎也不会抓取收录你的网站

11、网站被降权

如果文章质量过关,那么还是长时间不被收录,只有一个答案,唯一的解释就是,网站被降权了,请复查网站,是否有被降权的迹象。

这是文章不收录最常见的一种缘由,网站降权后,网站有可能会暂停收录,因为搜索引擎对这个网站不信任,重点对他初审。

12、网站改版

网站已经营运了一两年以后,感觉现今的模板不够好,于是就对网站进行全面改版,也会导致网站文章短暂的不收录。

对于网站改版后,网站内容出现不收录,很大可能是因为网站的程序换掉了,并且链接都发生了改变,这种大变动的改变必然会导致网站出现快照不更新、内容不被收录,网站排名全线增长的情况。

搜索引擎是以收录的页面来辨识网站的,如果忽然发觉你的网站变了一个样,搜索引擎就得对你的网站重新认识,从而把你的网站拉入考核期,看你的网站是否存在异常。

13、网站空间或服务器忽然不稳定

当搜索引擎通过其他外链达到网站的时侯,发现网站访问不了,那么他都会尽兴而回。这似乎一个老朋友想到你家作客,他去到家门口的时侯,他敲了半天的门都没有人你都没有下来迎接他,这时候不要说不收录了,没有降权就早已很不错了。

所以在网站建设前期,一定要选一个稳定的网站空间,这一点很重要。关于网站空间不稳定有什么影响,下一篇和你们详尽的说明。

14、搜索引擎算法更新

另外,还有一种缘由就是由于搜索引擎新算法的更新,有时候,因为搜索引擎新算法、新规则的颁布,我们的网站又违反了新算法的规则,也会导致网站短期的不收录,或者直接被降权。

对于这些缘由造成的不收录文章,只要我们依照搜索引擎新算法的规则,将网站完善或改进一下,很快就恢复了。

青梅SEO教学总结:关于老站不收录的缘由总共就这几点,根据自己网站的实际情况去结合,你的网站为什么不收录,然后去解决,相信你的网站会很快收录的。搜索引擎也是越来越智能化,所以我们要做的就是符合他的喜好度,来满足他,然后还要符合用户的喜欢,去统筹布局。

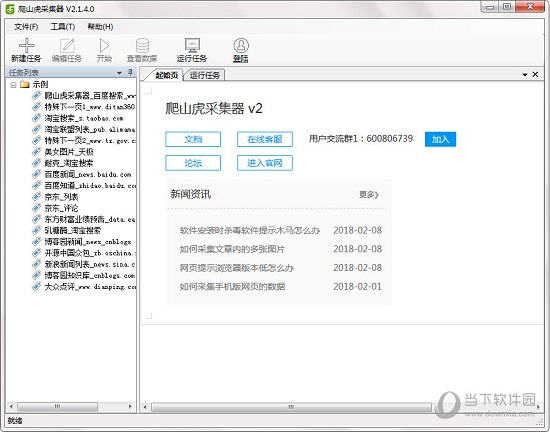

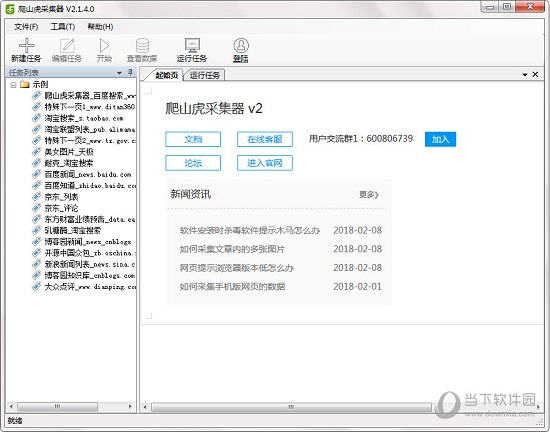

优采云采集器 v2.8 免费版

采集交流 • 优采云 发表了文章 • 0 个评论 • 406 次浏览 • 2020-08-12 07:40

软件特色:

1、适用各类网站 :能够采集互联网99%的网站,包括单页应用Ajax加载等等动态类型网站。

2、多引擎,高速稳定:内置高速浏览器引擎,还可以切换为HTTP引擎模式运行,采集数据愈发高效。还外置了JSON引擎,无需剖析JSON数据结构,可视化选定JSON内容。

3、零门槛:不懂网路爬虫技术,会上网,就会采集网站数据。

软件功能:

1、可视化向导

所有采集元素,自动生成采集数据。

2、计划任务

灵活定义运行时间,全自动运行。

3、多引擎支持

支持多个采集引擎,内置高速浏览器内核、HTTP引擎和JSON引擎。

4、智能辨识

可手动辨识网页列表、采集字段和分页等。

5、拦截恳求

自定义拦截域名,方便过滤站外广告,提高采集速度。

6、多种数据导入

可导入为Txt 、Excel、MySQL、SQLServer、 SQlite、Access、网站等。

亮点介绍:

1、软件操作简单,可通过键盘点击的形式轻松选定要抓取的内容;

2、支持三种高速引擎:浏览器引擎、HTTP引擎、JSON引擎,内置优化后的火狐浏览器,加上独创的内存优化让浏览器采集也可以高速运行,甚至可以快速转换为HTTP方法运行,享受更高的采集速度!而在抓取JSON数据时,同样可以使用浏览器可视化形式,通过键盘点选须要抓取的内容,完全不需要去剖析JSON数据结构,使非网页专业设计人士也可以轻松抓取须要的数据;

3、不用剖析网页恳求和源代码,却支持更多的网页采集;

4、先进的智能算法,可以一键生成目标元素XPATH、自动辨识网页列表、自动辨识分页中的下一页按键……

5、支持丰富的数据导入方法,可以导入为txt文件、html文件、csv文件、excel文件,也可以导入到已有的数据库,如sqlite数据库、access数据库、sqlserver数据库、mysql数据库,通过向导的方法简单映射数组,即可轻松导入到目标网站数据库中。

常见问题:

1、采集时如何防止重复到重复数据?

方法很简单,我们希望哪一个数组内容不容许出现重复,只要点击该数组表身上这个三角符号,再勾选“过滤重复”复选框,点击确定就可以了

2、如何自动生成主键?

点击“增加数组”按钮

点击列表中任意一行中要提取的元素,比如要提取标题和链接地址,鼠标左键点击一下该标题即可

当点击的是网页链接时,会提示是否用时要抓取链接地址

如果要同时提取链接标题和链接地址,点“是”,如果只要提取标题文本,点否,这里我们点“是”

系统会手动生成标题和链接地址数组,并在数组列表中显示出提取到的数组内容,当点击顶部表格数组标题时,会在网页上以红色背景高亮显示出匹配的内容。

如何还有标记列表中的其他数组,点击新增数组,重复以上操作即可。 查看全部

优采云采集器免费版是一款功能强悍而且实用的网页数据采集工具。这款软件具有零门槛、多引擎、多功能这几个特性。该软件还能使一个不懂网路爬虫技术的人,轻松的采集网络信息,适合99%的网站,同时它能够够智能的防止获得重复的数据。支持丰富的数据导入方法,可以导入为txt文件、html文件、csv文件、excel文件,也可以导入到已有的数据库,如sqlite数据库、access数据库、sqlserver数据库、mysql数据库,通过向导的方法简单映射数组,即可轻松导入到目标网站数据库中。感兴趣的同事快来下载吧。

软件特色:

1、适用各类网站 :能够采集互联网99%的网站,包括单页应用Ajax加载等等动态类型网站。

2、多引擎,高速稳定:内置高速浏览器引擎,还可以切换为HTTP引擎模式运行,采集数据愈发高效。还外置了JSON引擎,无需剖析JSON数据结构,可视化选定JSON内容。

3、零门槛:不懂网路爬虫技术,会上网,就会采集网站数据。

软件功能:

1、可视化向导

所有采集元素,自动生成采集数据。

2、计划任务

灵活定义运行时间,全自动运行。

3、多引擎支持

支持多个采集引擎,内置高速浏览器内核、HTTP引擎和JSON引擎。

4、智能辨识

可手动辨识网页列表、采集字段和分页等。

5、拦截恳求

自定义拦截域名,方便过滤站外广告,提高采集速度。

6、多种数据导入

可导入为Txt 、Excel、MySQL、SQLServer、 SQlite、Access、网站等。

亮点介绍:

1、软件操作简单,可通过键盘点击的形式轻松选定要抓取的内容;

2、支持三种高速引擎:浏览器引擎、HTTP引擎、JSON引擎,内置优化后的火狐浏览器,加上独创的内存优化让浏览器采集也可以高速运行,甚至可以快速转换为HTTP方法运行,享受更高的采集速度!而在抓取JSON数据时,同样可以使用浏览器可视化形式,通过键盘点选须要抓取的内容,完全不需要去剖析JSON数据结构,使非网页专业设计人士也可以轻松抓取须要的数据;

3、不用剖析网页恳求和源代码,却支持更多的网页采集;

4、先进的智能算法,可以一键生成目标元素XPATH、自动辨识网页列表、自动辨识分页中的下一页按键……

5、支持丰富的数据导入方法,可以导入为txt文件、html文件、csv文件、excel文件,也可以导入到已有的数据库,如sqlite数据库、access数据库、sqlserver数据库、mysql数据库,通过向导的方法简单映射数组,即可轻松导入到目标网站数据库中。

常见问题:

1、采集时如何防止重复到重复数据?

方法很简单,我们希望哪一个数组内容不容许出现重复,只要点击该数组表身上这个三角符号,再勾选“过滤重复”复选框,点击确定就可以了

2、如何自动生成主键?

点击“增加数组”按钮

点击列表中任意一行中要提取的元素,比如要提取标题和链接地址,鼠标左键点击一下该标题即可

当点击的是网页链接时,会提示是否用时要抓取链接地址

如果要同时提取链接标题和链接地址,点“是”,如果只要提取标题文本,点否,这里我们点“是”

系统会手动生成标题和链接地址数组,并在数组列表中显示出提取到的数组内容,当点击顶部表格数组标题时,会在网页上以红色背景高亮显示出匹配的内容。

如何还有标记列表中的其他数组,点击新增数组,重复以上操作即可。

优采云采集器Mac版下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 266 次浏览 • 2020-08-12 07:39

软件介绍

优采云采集器是由前微软搜索技术团队基于人工智能技术研制的新一代网页采集软件。

该软件功能强悍,操作简单,是为广大无编程基础的产品、运营、销售、金融、新闻、电商和数据剖析从业者,以及政府机关和学术研究等用户量身构建的一款产品。

优采云采集器除了才能进行数据的自动化采集,而且在采集过程中还可以对数据进行清洗。在数据源头即可实现多种内容的过滤。

通过使用优采云采集器,用户还能快速、准确地获取海量网页数据,从而彻底解决了人工搜集数据所面临的各类困局,降低了获取信息的成本,提高了工作效率。

软件特点

1、智能辨识数据,小白利器

智能模式:基于人工智能算法,只需输入网址能够智能辨识列表数据、表格数据和分页按键,不需要配置任何采集规则,一键采集。

自动辨识:列表、表格、链接、图片、价格等

2、可视化点击,简单上手

流程图模式:只需按照软件提示在页面中进行点击操作,完全符合人为浏览网页的思维方法,简单几步即可生成复杂的采集规则,结合智能辨识算法,任何网页的数据都能轻松采集。

可模拟操作: 输入文本、点击、移动滑鼠、下拉框、滚动页面、等待加载、循环操作和判别条件等。

3、支持多种数据导入方法

采集结果可以导入到本地,支持TXT、EXCEL、CSV和HTML文件格式,也可以直接发布到数据库(MySQL、MongoDB、SQL Server、PostgreSQL)供您使用。

4、功能强悍,提供企业级服务

优采云采集器提供丰富的采集功能,无论是采集稳定性或是采集效率,都还能满足个人、团队和企业级采集需求。

丰富的功能: 定时采集,自动导入,文件下载,加速引擎,按组启动和导入,Webhook,RESTful API,智能辨识SKU和电商大图等。

5、云端帐号,方便快捷

创建优采云采集器帐号并登陆,您的所有采集任务都将手动加密保存到优采云的云端服务器,无需害怕采集任务遗失,而且十分安全,只有您自己在本地登陆客户端后才会查看。优采云采集器对帐号没有终端绑定限制,您切换终端时采集任务也会同步更新,任务管理便捷快捷。

6、全平台支持,无缝切换

同时支持Windows、Mac和Linux全操作系统的采集软件,各平台版本完全相同,无缝切换。

优采云采集器容易出现的问题

1、为什么采集数据提早停止了?

如果您遇见采集提前停止的问题,请根据以下步骤自检一下:

第一步:请确认您在浏览器中能看到多少内容

有的时候搜索显示数目和你最终能看得见的数目不是一致的,请确认您能看到多少条数据,然后再确定采集是提早停止还是正常停止。

第二步:采集结果数目和在浏览器中见到的数目不一致

在采集过程中,如果碰到这个问题,有以下两种可能性:

第一种可能性是采集速度过快而网页加载时间过慢,从而造成难以采集到网页中的数据。

遇到这些情况时请降低恳求等待时间,等待时间长一点以后,就有足够的时间留给网页加载内容。

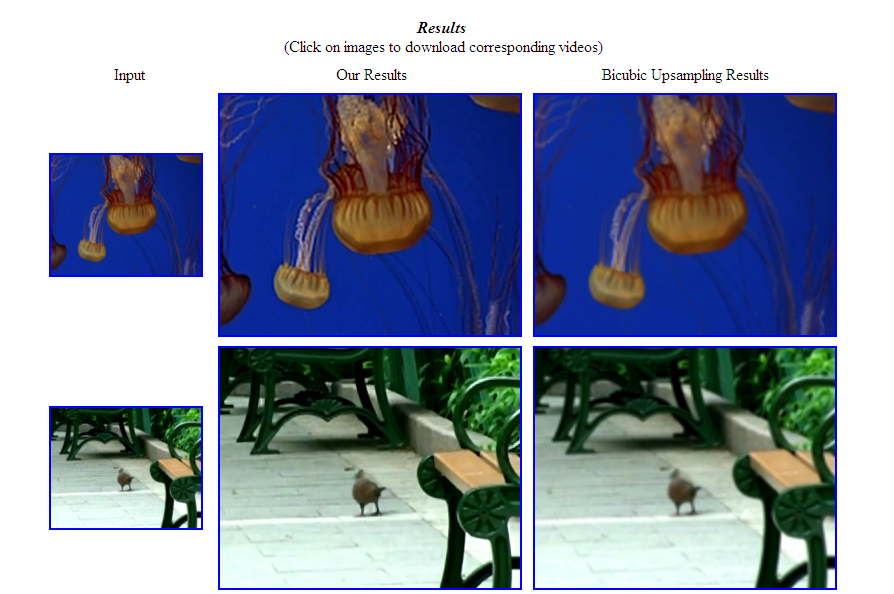

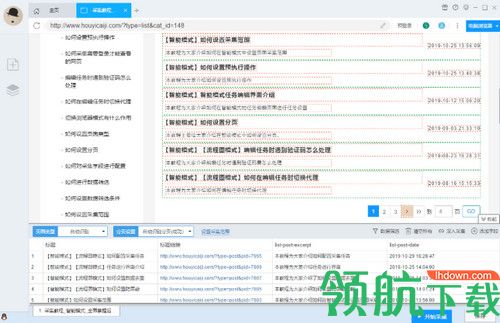

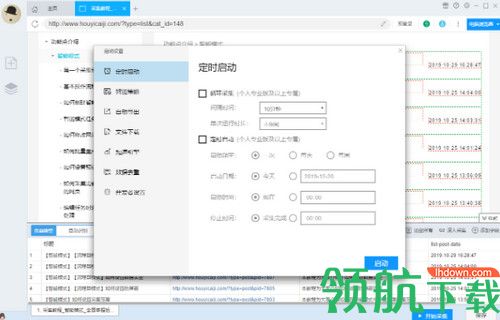

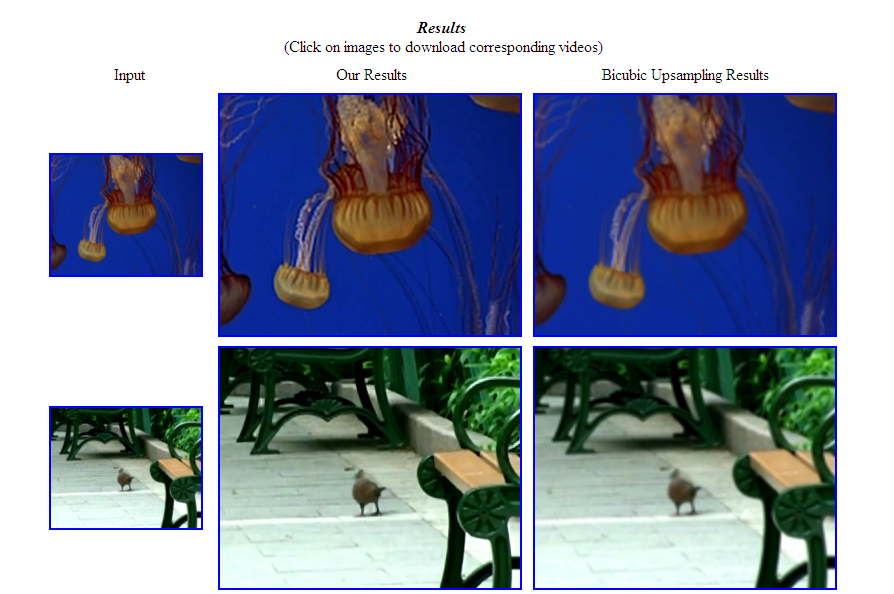

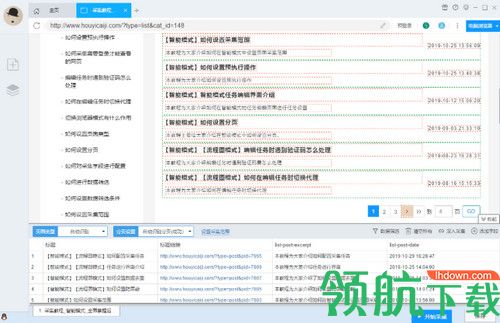

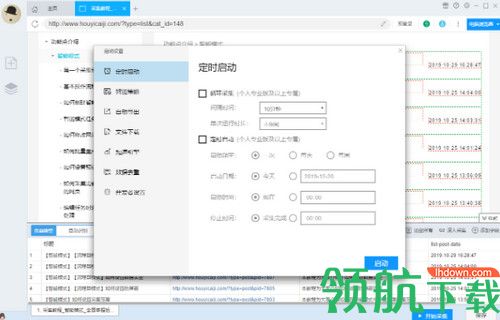

请求等待时间的设置在 启动设置—>智能策略中,如下图所示:

第二种可能性是你遇见了其他问题

我们可以通过在运行过程中,点击运行界面中的“查看网页”来观察一下当前的网页内容是否正常,是否未能正常显示,是否出现异常提示等。

如果出现了上述情况,我们可以通过增加采集速度、切换代理IP、手动打码等形式,至于哪种方法可以起作用,这个须要测试才晓得,不同的网站问题不同,没有一个统一的解决方案。

2、为什么采集字段不全?

字段不全通常有以下两种情况:

第一种,由于列表元素的结构不同,有些元素中有的数组其他元素中没有,这是正常的现象,请你们先在网页中确认对应元素中是否存在你想要的数组。

第二种,页面结构发生了变化,这种一般会发生在同一个搜索结果中收录多种页面结构的场景,例如搜索引擎的搜索结果(收录好多种网站)。

3、为什么采集数据重复?

首先请确认你已然看过视频教程,你的采集任务没有页面类型的设置问题,即错把单页类型设置为列表类型,或是你错误地理解了循环采集的使用技巧。

然后请确定你是多次反复采集数据出现重复还是某一次单独采集出现了重复数据。

在未更改采集任务时,每一次运行采集任务都是从头开始采集,所以每一次采集的数据都是重复的,这是正常的。

如果是在单次采集时出现了重复数据,请确认是否满足以下情况:

第一种:重复数据均为最后一页的数据,这种有可能是翻到最后一页无法停止翻页,请尝试更改采集范围,然后看是否就会出现重复数据的情况。

第二种:重复数据为中间页的数据,这种情况未能直接得出结论。

更新内容

1. 优化兼容ng-click的按键点击

2. 优化启动任务时可设置逐行滚动的最小滚动距离

3. 修复部份显示问题 查看全部

优采云采集器Mac版是一款功能强悍的网路爬虫软件,你只需输入网址,它都会智能采集内容。你可以通过它采集网页上的图片、文章或者表格等,允许将采集的数据以不同的格式导入。

软件介绍

优采云采集器是由前微软搜索技术团队基于人工智能技术研制的新一代网页采集软件。

该软件功能强悍,操作简单,是为广大无编程基础的产品、运营、销售、金融、新闻、电商和数据剖析从业者,以及政府机关和学术研究等用户量身构建的一款产品。

优采云采集器除了才能进行数据的自动化采集,而且在采集过程中还可以对数据进行清洗。在数据源头即可实现多种内容的过滤。

通过使用优采云采集器,用户还能快速、准确地获取海量网页数据,从而彻底解决了人工搜集数据所面临的各类困局,降低了获取信息的成本,提高了工作效率。

软件特点

1、智能辨识数据,小白利器

智能模式:基于人工智能算法,只需输入网址能够智能辨识列表数据、表格数据和分页按键,不需要配置任何采集规则,一键采集。

自动辨识:列表、表格、链接、图片、价格等

2、可视化点击,简单上手

流程图模式:只需按照软件提示在页面中进行点击操作,完全符合人为浏览网页的思维方法,简单几步即可生成复杂的采集规则,结合智能辨识算法,任何网页的数据都能轻松采集。

可模拟操作: 输入文本、点击、移动滑鼠、下拉框、滚动页面、等待加载、循环操作和判别条件等。

3、支持多种数据导入方法

采集结果可以导入到本地,支持TXT、EXCEL、CSV和HTML文件格式,也可以直接发布到数据库(MySQL、MongoDB、SQL Server、PostgreSQL)供您使用。

4、功能强悍,提供企业级服务

优采云采集器提供丰富的采集功能,无论是采集稳定性或是采集效率,都还能满足个人、团队和企业级采集需求。

丰富的功能: 定时采集,自动导入,文件下载,加速引擎,按组启动和导入,Webhook,RESTful API,智能辨识SKU和电商大图等。

5、云端帐号,方便快捷

创建优采云采集器帐号并登陆,您的所有采集任务都将手动加密保存到优采云的云端服务器,无需害怕采集任务遗失,而且十分安全,只有您自己在本地登陆客户端后才会查看。优采云采集器对帐号没有终端绑定限制,您切换终端时采集任务也会同步更新,任务管理便捷快捷。

6、全平台支持,无缝切换

同时支持Windows、Mac和Linux全操作系统的采集软件,各平台版本完全相同,无缝切换。

优采云采集器容易出现的问题

1、为什么采集数据提早停止了?

如果您遇见采集提前停止的问题,请根据以下步骤自检一下:

第一步:请确认您在浏览器中能看到多少内容

有的时候搜索显示数目和你最终能看得见的数目不是一致的,请确认您能看到多少条数据,然后再确定采集是提早停止还是正常停止。

第二步:采集结果数目和在浏览器中见到的数目不一致

在采集过程中,如果碰到这个问题,有以下两种可能性:

第一种可能性是采集速度过快而网页加载时间过慢,从而造成难以采集到网页中的数据。

遇到这些情况时请降低恳求等待时间,等待时间长一点以后,就有足够的时间留给网页加载内容。

请求等待时间的设置在 启动设置—>智能策略中,如下图所示:

第二种可能性是你遇见了其他问题

我们可以通过在运行过程中,点击运行界面中的“查看网页”来观察一下当前的网页内容是否正常,是否未能正常显示,是否出现异常提示等。

如果出现了上述情况,我们可以通过增加采集速度、切换代理IP、手动打码等形式,至于哪种方法可以起作用,这个须要测试才晓得,不同的网站问题不同,没有一个统一的解决方案。

2、为什么采集字段不全?

字段不全通常有以下两种情况:

第一种,由于列表元素的结构不同,有些元素中有的数组其他元素中没有,这是正常的现象,请你们先在网页中确认对应元素中是否存在你想要的数组。

第二种,页面结构发生了变化,这种一般会发生在同一个搜索结果中收录多种页面结构的场景,例如搜索引擎的搜索结果(收录好多种网站)。

3、为什么采集数据重复?

首先请确认你已然看过视频教程,你的采集任务没有页面类型的设置问题,即错把单页类型设置为列表类型,或是你错误地理解了循环采集的使用技巧。

然后请确定你是多次反复采集数据出现重复还是某一次单独采集出现了重复数据。

在未更改采集任务时,每一次运行采集任务都是从头开始采集,所以每一次采集的数据都是重复的,这是正常的。

如果是在单次采集时出现了重复数据,请确认是否满足以下情况:

第一种:重复数据均为最后一页的数据,这种有可能是翻到最后一页无法停止翻页,请尝试更改采集范围,然后看是否就会出现重复数据的情况。

第二种:重复数据为中间页的数据,这种情况未能直接得出结论。

更新内容

1. 优化兼容ng-click的按键点击

2. 优化启动任务时可设置逐行滚动的最小滚动距离

3. 修复部份显示问题

舆情检测系统蓝皮书

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2020-08-12 03:33

安吉专业舆情检测系统功能

网络舆情采集

安吉专业舆情监控系统依据用户配臵的采集策略手动采集网络上的各色文本信息。采集

器在互联网上不断采集各类信息,都可进行统一加工过滤、自动分类,自动提取标题、来源、发布时间、正文等信息,形成舆情数据库。

提供多种采集策略

“定向采集”:用于实时监控互联网上指定网站的的重要信息,及时发觉有价值的信息。“定向采集”相对于搜索引擎采集具有获取数据速度快、信息采集准确度高等特性。 “全网采集”:通过设臵关键字策略借助Google、Baidu、Bing等搜索引擎进行全网搜索。相对于“定向采集”该方法大大提升搜索覆盖率,使信息获取不留死角。

丰富的信息采集内容

支持网页结构手动剖析

信息采集器实现了基于网页结构的统计剖析算法,能够依据模板标签手动辨识、判断出每一篇文章正确的标题、时间、作者、来源等关键及其评论信息,满足舆情剖析的须要。

支持Javascript、Ajax等动态技术生成的页面采集

支持登陆采集

支持RSS解析

许多博客、新闻评论采用RSS实现内容共享,除网页基本信息,RSS会收录更丰富的元数据信息,比如标题、作者、发表日期、分类、关键词等,这些元数据对于舆情剖析有 重要的价值,信息采集工具实现了对RSS聚合内容的手动解析和采集。

自动编码辨识

URL去重

信息采集器启动工作的过程中,对同一个网页不进行多次下载,因为重复下载除了会浪费资源,还会为搜索引擎系统降低负荷。URL去重控制这些重复性,很好的解决同一个网页重复下载的问题。

信息采集器采用领先的unicode编码技术,支持多种语言格式网页的采集。 通过对采集器进行登陆设定,可以实现对须要登陆验证网站的信息采集。 实现对采用动态技术生成博客、论坛、评论等信息确切和全面的采集。

查看全部

专业舆情检测系统

安吉专业舆情检测系统功能

网络舆情采集

安吉专业舆情监控系统依据用户配臵的采集策略手动采集网络上的各色文本信息。采集

器在互联网上不断采集各类信息,都可进行统一加工过滤、自动分类,自动提取标题、来源、发布时间、正文等信息,形成舆情数据库。

提供多种采集策略

“定向采集”:用于实时监控互联网上指定网站的的重要信息,及时发觉有价值的信息。“定向采集”相对于搜索引擎采集具有获取数据速度快、信息采集准确度高等特性。 “全网采集”:通过设臵关键字策略借助Google、Baidu、Bing等搜索引擎进行全网搜索。相对于“定向采集”该方法大大提升搜索覆盖率,使信息获取不留死角。

丰富的信息采集内容

支持网页结构手动剖析

信息采集器实现了基于网页结构的统计剖析算法,能够依据模板标签手动辨识、判断出每一篇文章正确的标题、时间、作者、来源等关键及其评论信息,满足舆情剖析的须要。

支持Javascript、Ajax等动态技术生成的页面采集

支持登陆采集

支持RSS解析

许多博客、新闻评论采用RSS实现内容共享,除网页基本信息,RSS会收录更丰富的元数据信息,比如标题、作者、发表日期、分类、关键词等,这些元数据对于舆情剖析有 重要的价值,信息采集工具实现了对RSS聚合内容的手动解析和采集。

自动编码辨识

URL去重

信息采集器启动工作的过程中,对同一个网页不进行多次下载,因为重复下载除了会浪费资源,还会为搜索引擎系统降低负荷。URL去重控制这些重复性,很好的解决同一个网页重复下载的问题。

信息采集器采用领先的unicode编码技术,支持多种语言格式网页的采集。 通过对采集器进行登陆设定,可以实现对须要登陆验证网站的信息采集。 实现对采用动态技术生成博客、论坛、评论等信息确切和全面的采集。

如何能够防止命中百度劲风算法?怎么整改?

采集交流 • 优采云 发表了文章 • 0 个评论 • 143 次浏览 • 2020-08-11 20:12

针对劲风算法的整改建议一、内容与站点本身领域不符,或站点无专注领域,多为采集拼凑的内容

如上标题,这几本就是聚合站了。

算法中列出了2种网站的内容形态。为了一些菜鸟易于理解,下面对这2个点进行一下解释:

内容与站点本身领域不符:例如你的网站是做SEO培训的,但是网站中收录了旅游、美食、游戏等内容。

站点无专注领域:网站内杂七杂八各类内容,又做SEO培训,又搞旅游,甚至还有游戏下载。百度都不知道你专注的领域是哪些!这里要说明的是假如你是资讯新闻站,可以忽视这一点。

多为采集拼凑的内容:这一点是基于前面1、2点的一种内容生成方式。一般来说一个零乱无明晰所属领域的站点,内容确实是通过大量采集搞来的。

基于这些行为的整改建议:如果你的网站符合上述的情况,建议你保留你最初心的网站类型,并将其他领域的页面进行删掉,查询早已删掉的页面返回状态码是404后,将这种404链接通过百度搜索资源平台的死链递交工具,把那些链接进行递交。等待生效即可。

另外,如果网站存在恶意采集的行为,且网页的排版布局存在不符合用体验的嫌疑,建议一并进行整改。

二、页面内容与标题及页面中标记的标签不符

我们这个聚铰链的关键词与这个网页内调阅的内容对比,不相关。这一点基本就是针对聚合页内容相关性做的惩罚。

不是悉心做的一些聚合页基本都存在这类问题。这个聚铰链的主题本身是网站权重,而内容有SEO服务、与网站权重无关的课程以及偏离主题更离谱的内容。

基于这些行为的整改建议:针对tag标签页(手动选择的),将你网站内的所有内容基于tag标签进行整体的更改,找到相关的tag标签。整改率最低建议达到80%。

如果你是基于其他方法实现的聚合页,首先风险确实很大。我能给出的整改建议是:尽可能的将调阅的内容与主题的相关性达到60%以上。如果调阅的资源较少,可以放大调阅的类目。例如基于robots的聚合页,可以调阅robots的文章、问答、课程以及工具等。扩大内容资源量,以保证相关性。从而实现主题与调阅内容的相关性。避免被劲风算法惩罚。

三、由网站搜索功能生成的静态搜索结果页

如标题,一目了然。这也是最常见、最快速生成聚铰链的形式被大量使用。特别是针对一些小型网站而言。

整改建议:找到大家的技术,提升大家自己的搜索引擎的检索能力。调取更为相关的内容。如果是基于网站搜索功能生成的搜索列表页,最好把这个页面做一下改版。将这个页面弄成多维元素的专题页面(工作量巨大),这样做下来的页面既能满足用户需求,又能得到挺好的用户体验,更加可以推动这类型网页的转化率。

四、空短、无有效信息、失效的聚铰链

由于一次性生成大量聚铰链,且内容为空、或者内容极少(基本没啥参考价值了)的聚合页。我的整改建议为:在保证每一个主题调阅内容的相关性之外,利用调阅规则,将调阅的范畴放大。

例如,将你所有的tag标签进行分类,然后a标签调阅的内容不足x条或为空时。那就调阅和这个表填同一分类下的其他标签的内容进行补充,补充多少条建议不高于5条。

这种方法相对很难满足相关性,另外一个建议就是:利用程序辨识每一个tag标签所属的内容量,如果量高于5条,则返回404或302指向一个固定页面。待检索内容等于或小于5时,方可正常访问。如果是404,那么建议进行url提取,并递交404。302的危险系数也比较大,斟酌而行!

而针对失效的聚铰链,且难以降低内容本身的有效性了。建议进行删掉,并递交404!

五、关于劲风算法整改的总结

劲风算法的推出,主要是针对恶劣的聚合页而言的。而定义恶劣最根本的出发点再与你的内容难以满足搜索用户需求。所以我们基于满足用户需求做到如下几点最为关键!

每一个聚铰链的主题和内容都是相关的,通过搜索进来的用户可以满足其搜索需求。用户搜索需求满足,指的是内容,你调阅的内容标题、内容主体都应当可以结局需求;满足用户体验:围绕整个网页而言,从访问速率提高、避免广告影响浏览、页面布局清洗、主体内容与网页其他元素有显著的区别、主体内容在首屏就应当出现。这些都是基于体验而言,加分项不是必须项(至少有其它算法控制着那些)!采集,如果是恶劣的采集行为,飓风算法也在等着你!

说一千、道一万,搜索引擎的所有算法的本质基于两点:1、内容可以满足需求、2、用户浏览网页时,体验良好!

如上是针对怎样防止命中百度飓风算法的一些整改建议,希望对你有所帮助!如果你还有其他问题,可以通过问答社区进行提问,我会在第一时间回复你!

延展阅读

原创文章:《如何能够防止命中百度劲风算法?怎么整改?》,作者:赵彦刚。不经准许,请勿转载,如若转载,请标明出处: 查看全部

百度最新公布的劲风算法,其主要意图是惩罚单纯以获取流量不顾及搜索用户体验的恶劣聚合页。而避开命中劲风算法的思索维度,就定格在了我们是不是有聚合页?如果有聚合页,那这个聚合页是可以满足用户需求和体验的还是不可以满足呢,百度给出了4种会惩罚的类型,下面我针对这四种情况给出你一些整改建议。

针对劲风算法的整改建议一、内容与站点本身领域不符,或站点无专注领域,多为采集拼凑的内容

如上标题,这几本就是聚合站了。

算法中列出了2种网站的内容形态。为了一些菜鸟易于理解,下面对这2个点进行一下解释:

内容与站点本身领域不符:例如你的网站是做SEO培训的,但是网站中收录了旅游、美食、游戏等内容。

站点无专注领域:网站内杂七杂八各类内容,又做SEO培训,又搞旅游,甚至还有游戏下载。百度都不知道你专注的领域是哪些!这里要说明的是假如你是资讯新闻站,可以忽视这一点。

多为采集拼凑的内容:这一点是基于前面1、2点的一种内容生成方式。一般来说一个零乱无明晰所属领域的站点,内容确实是通过大量采集搞来的。

基于这些行为的整改建议:如果你的网站符合上述的情况,建议你保留你最初心的网站类型,并将其他领域的页面进行删掉,查询早已删掉的页面返回状态码是404后,将这种404链接通过百度搜索资源平台的死链递交工具,把那些链接进行递交。等待生效即可。

另外,如果网站存在恶意采集的行为,且网页的排版布局存在不符合用体验的嫌疑,建议一并进行整改。

二、页面内容与标题及页面中标记的标签不符

我们这个聚铰链的关键词与这个网页内调阅的内容对比,不相关。这一点基本就是针对聚合页内容相关性做的惩罚。

不是悉心做的一些聚合页基本都存在这类问题。这个聚铰链的主题本身是网站权重,而内容有SEO服务、与网站权重无关的课程以及偏离主题更离谱的内容。

基于这些行为的整改建议:针对tag标签页(手动选择的),将你网站内的所有内容基于tag标签进行整体的更改,找到相关的tag标签。整改率最低建议达到80%。

如果你是基于其他方法实现的聚合页,首先风险确实很大。我能给出的整改建议是:尽可能的将调阅的内容与主题的相关性达到60%以上。如果调阅的资源较少,可以放大调阅的类目。例如基于robots的聚合页,可以调阅robots的文章、问答、课程以及工具等。扩大内容资源量,以保证相关性。从而实现主题与调阅内容的相关性。避免被劲风算法惩罚。

三、由网站搜索功能生成的静态搜索结果页

如标题,一目了然。这也是最常见、最快速生成聚铰链的形式被大量使用。特别是针对一些小型网站而言。

整改建议:找到大家的技术,提升大家自己的搜索引擎的检索能力。调取更为相关的内容。如果是基于网站搜索功能生成的搜索列表页,最好把这个页面做一下改版。将这个页面弄成多维元素的专题页面(工作量巨大),这样做下来的页面既能满足用户需求,又能得到挺好的用户体验,更加可以推动这类型网页的转化率。

四、空短、无有效信息、失效的聚铰链

由于一次性生成大量聚铰链,且内容为空、或者内容极少(基本没啥参考价值了)的聚合页。我的整改建议为:在保证每一个主题调阅内容的相关性之外,利用调阅规则,将调阅的范畴放大。

例如,将你所有的tag标签进行分类,然后a标签调阅的内容不足x条或为空时。那就调阅和这个表填同一分类下的其他标签的内容进行补充,补充多少条建议不高于5条。

这种方法相对很难满足相关性,另外一个建议就是:利用程序辨识每一个tag标签所属的内容量,如果量高于5条,则返回404或302指向一个固定页面。待检索内容等于或小于5时,方可正常访问。如果是404,那么建议进行url提取,并递交404。302的危险系数也比较大,斟酌而行!

而针对失效的聚铰链,且难以降低内容本身的有效性了。建议进行删掉,并递交404!

五、关于劲风算法整改的总结

劲风算法的推出,主要是针对恶劣的聚合页而言的。而定义恶劣最根本的出发点再与你的内容难以满足搜索用户需求。所以我们基于满足用户需求做到如下几点最为关键!

每一个聚铰链的主题和内容都是相关的,通过搜索进来的用户可以满足其搜索需求。用户搜索需求满足,指的是内容,你调阅的内容标题、内容主体都应当可以结局需求;满足用户体验:围绕整个网页而言,从访问速率提高、避免广告影响浏览、页面布局清洗、主体内容与网页其他元素有显著的区别、主体内容在首屏就应当出现。这些都是基于体验而言,加分项不是必须项(至少有其它算法控制着那些)!采集,如果是恶劣的采集行为,飓风算法也在等着你!

说一千、道一万,搜索引擎的所有算法的本质基于两点:1、内容可以满足需求、2、用户浏览网页时,体验良好!

如上是针对怎样防止命中百度飓风算法的一些整改建议,希望对你有所帮助!如果你还有其他问题,可以通过问答社区进行提问,我会在第一时间回复你!

延展阅读

原创文章:《如何能够防止命中百度劲风算法?怎么整改?》,作者:赵彦刚。不经准许,请勿转载,如若转载,请标明出处:

浅析深度优先与广度优先的遍历算法(简单实践)

采集交流 • 优采云 发表了文章 • 0 个评论 • 190 次浏览 • 2020-08-11 04:49

深度优先和广度优先算法在爬虫遍历页面url的算法的时侯常常用到,笔者在本文中主要与你们分享讲解这两个算法的原理。

image

一、网站的url结构

每个网站都是有一定结构层次,在一个主域名下可能会有多个内容模块,网站的所有内容都是类似一个树状结构一层一层的,如下图:

image

二、原理分析

我们把网站的结构理解为一颗树的结构,每一个页面就是一个节点,如图:

image

▎深度优先算法

通过深度优先遍历下来的结果是: A-->B-->D-->H-->E-->C-->F-->G

深度优先算法过程简略来说是对每一个可能的分支路径深入到不能再深入为止,而且每位节点只能访问一次:

●首先访问根节点,然后依次从根节点的未被访问的邻接点出发,进行深度优先遍历,直至和根节点有路径相通的节点都被访问。

●若此潮流有节点未被访问,则从一个未被访问的节点出发,重新进行深度优先遍历,直到所有顶点均被访问过。

由深度优先算法的规则可知该算法具体实现使用递归实现的。

▎广度优先算法

通过广度优先遍历下来的结果是: ** A-->B-->C-->D-->E-->F-->G-->H**

广度优先算法是从一个节点开始,根据层次从上到下的遍历节点,在同一层中从左到右遍历节点:

●首先访问根节点,然后访问离根节点距离为1的顶点。假设有3个节点与根节点相邻,深度优化搜索会在访问根节点后访问这3个节点。

●在完成访问离根节点距离为1的节点后,将它取出并重复相同的过程。其中哪一个节点是第一个节点,这依照队列的数据结构来处理。

所以也把广度优化算法称为纵向次序遍历,因为它一层一层地访问节点。广度优化搜索通过队列实现。

三、简单实践

这两种算法在爬虫遍历页面时常常被用到,我用了广度优先算法做了一个简单的爬取网站所有 url 的 demo 。这个 demo 主要用到了 python3 的三个库 urllib 、BeautifulSoup 以及ss l。

Urllib 库拿来网页恳求、响应获取;BeautifulSoup 库拿来将html解析为对象进行处理;ssl是解决访问Https时不受信任SSL证书问题;这几个库还有其他功能,感兴趣的可以去了解它们的API:

●导入urllib、BeautifulSoup库

import ssl

import urllib.request

from bs4 import BeautifulSoup

●获取网页内容

#解决访问Https时不受信任SSL证书问题

context = ssl._create_unverified_context()

#使用urllib库抓取URL内容

resp=urllib.request.urlopen(link_url, context=context)

html=resp.read()

●解析网页内容(这边只解析提取网页上面的链接)

#使用BeautifulSoup库解析网页内容

soup = BeautifulSoup(html, 'html.parser')

tags = soup.find_all('a')

for tag in tags:

child_urls.add(tag.attrs('href'))

●使用广度优先算法进行爬取

while not queue.empty():

current_url = queue.get()

if current_url not in found_urls:

found_urls.add(current_url)

quene.put(getLinkUrls(current_url))

四、比较剖析

◆深度优先算法采用栈的形式,有回溯操作,不会保留全部节点,占用空间少,但运行速率较慢。

◆广度优先算法采用队列的形式,无回溯操作,保留全部节点,运行速率较快,但占用空间较多。

◆深度优先算法和广度优先算法的时间复杂度都是O(n2),n为节点数。

image

五、工具推荐

借助代码去抓取想要的数据并进行可视化剖析是最方便灵活的,但是好多产品和营运说到学代码,可能马上就舍弃了。

那么有没有不懂代码就可以实现抓取数据,进行可视化剖析的方式呢?以下就是我为你们推荐的三款工具:

优采云可以比较容易的从网页精确采集你须要的数据,内容涵括电商类、生活服务类、社交媒体类、论坛类。

**▎优采云采集器优点:

●操作简单,完全可视化图形操作,无需专业IT人员,任何会使用笔记本上网的人都可以轻松把握。

●采集任务手动分配到云端多台服务器同时执行,提高采集效率,可以挺短的时间内 获取成千上万条信息。

●模拟人的操作思维模式,可以登录,输入数据,点击链接,按钮等,还能对不同情况采取不同的采集流程。

●内置可扩充的OCR插口,支持解析图片中的文字,可将图片上的文字提取下来。

●采集任务手动运行,可以根据指定的周期手动采集,并且还支持最快一分钟一次的实时采集。

●内置从入门到精通所须要的视频教程,2分钟才能上手使用,另外还有文档,论坛,qq群等。

**▎优采云采集器缺点:

●它又免费版本,当时好多功能须要付费或则积分。

●大量采集数据的时侯,容易出现采集不全的情况。

●判断语录较弱,无法进行复杂判定,也未能执行复杂逻辑。

image

优采云采集器组建的比较久,经过了十几年的迭代,可以实现抓取、清洗、分析,挖掘及最终的可用数据呈现,一整套服务。

▎优采云采集器优点:

●采集原理是基于 web 结构的源代码提取,几乎适用于所有的网页,以及网页中才能见到的所有内容;

●支持插口和插件多种扩充延展,满足愈发多元化的使用需求,使优采云采集器真正做到全网通用。

●在每位功能上都做了优化设置,除了最基础的数据采集,更是融入了强悍的数据处理和数据发布功能,全面建立了对于数据借助的整个流程。

●优采云采集器在许多细节操作中配置多项可选形式。

●分布式高速采集系统,占用资源少。

●实时地监控采集,数据不易遗漏。

▎优采云采集器缺点:

●规则配置繁杂。

●比较占用显存和CPU资源,大批量采集速度不行,资源回收控制得不好。

●高级功能必须付费版能够使用。

image

Tableau是数据可视化做的最好的平台之一,功能非常强悍。

▎Tableau 优点:

●优秀的数据可视化展示疗效,数据图表制做能力强

●操作简单,上手快不需要写代码,数据的导出和加载都是向导式

●内置美观的可视化图表,不用考虑配色,表格处理好格式即可。

▎Tableau 缺点:

●基于数据查询的工具,难以处理不规范数据,难以转化复杂模型。

●对输入数据类型有要求,运行上去比较慢,且只能支持PC笔记本,这也是好多Newsroom后来抛弃它的诱因。

●本身没有前端数据库房,宣称自己是显存BI,实际用上去对硬件要求极高,对于超千万条的数据剖析,必须借助于其他ETL工具处理好数据再进行后端剖析

●无法支持中国式复杂表样

●本地化服务差

●价格高昂

image

由此可见,工具有很多优点,但也有局限,对于有大量数据需求以及比较复杂的需求时侯还是须要通过代码实现,建议感兴趣的产品和营运可以稍稍了解下 python 。

image

以上,就是我对深度优先与广度优先的遍历算法的个人理解以及部份推荐的三个工具,大数据时代的到来,对数据爬取的需求越来越大,让我们一起学习上去。 查看全部

前段时间和产品人员、运营人员聊产品相关的事情,他们提出想通过搜集一些网站数据去剖析其它产品功能的数据情况以及拟定推广计划,因此去了解了爬虫相关的知识。

深度优先和广度优先算法在爬虫遍历页面url的算法的时侯常常用到,笔者在本文中主要与你们分享讲解这两个算法的原理。

image

一、网站的url结构

每个网站都是有一定结构层次,在一个主域名下可能会有多个内容模块,网站的所有内容都是类似一个树状结构一层一层的,如下图:

image

二、原理分析

我们把网站的结构理解为一颗树的结构,每一个页面就是一个节点,如图:

image

▎深度优先算法

通过深度优先遍历下来的结果是: A-->B-->D-->H-->E-->C-->F-->G

深度优先算法过程简略来说是对每一个可能的分支路径深入到不能再深入为止,而且每位节点只能访问一次:

●首先访问根节点,然后依次从根节点的未被访问的邻接点出发,进行深度优先遍历,直至和根节点有路径相通的节点都被访问。

●若此潮流有节点未被访问,则从一个未被访问的节点出发,重新进行深度优先遍历,直到所有顶点均被访问过。

由深度优先算法的规则可知该算法具体实现使用递归实现的。

▎广度优先算法

通过广度优先遍历下来的结果是: ** A-->B-->C-->D-->E-->F-->G-->H**

广度优先算法是从一个节点开始,根据层次从上到下的遍历节点,在同一层中从左到右遍历节点:

●首先访问根节点,然后访问离根节点距离为1的顶点。假设有3个节点与根节点相邻,深度优化搜索会在访问根节点后访问这3个节点。

●在完成访问离根节点距离为1的节点后,将它取出并重复相同的过程。其中哪一个节点是第一个节点,这依照队列的数据结构来处理。

所以也把广度优化算法称为纵向次序遍历,因为它一层一层地访问节点。广度优化搜索通过队列实现。

三、简单实践

这两种算法在爬虫遍历页面时常常被用到,我用了广度优先算法做了一个简单的爬取网站所有 url 的 demo 。这个 demo 主要用到了 python3 的三个库 urllib 、BeautifulSoup 以及ss l。

Urllib 库拿来网页恳求、响应获取;BeautifulSoup 库拿来将html解析为对象进行处理;ssl是解决访问Https时不受信任SSL证书问题;这几个库还有其他功能,感兴趣的可以去了解它们的API:

●导入urllib、BeautifulSoup库

import ssl

import urllib.request

from bs4 import BeautifulSoup

●获取网页内容

#解决访问Https时不受信任SSL证书问题

context = ssl._create_unverified_context()

#使用urllib库抓取URL内容

resp=urllib.request.urlopen(link_url, context=context)

html=resp.read()

●解析网页内容(这边只解析提取网页上面的链接)

#使用BeautifulSoup库解析网页内容

soup = BeautifulSoup(html, 'html.parser')

tags = soup.find_all('a')

for tag in tags:

child_urls.add(tag.attrs('href'))

●使用广度优先算法进行爬取

while not queue.empty():

current_url = queue.get()

if current_url not in found_urls:

found_urls.add(current_url)

quene.put(getLinkUrls(current_url))

四、比较剖析

◆深度优先算法采用栈的形式,有回溯操作,不会保留全部节点,占用空间少,但运行速率较慢。

◆广度优先算法采用队列的形式,无回溯操作,保留全部节点,运行速率较快,但占用空间较多。

◆深度优先算法和广度优先算法的时间复杂度都是O(n2),n为节点数。

image

五、工具推荐

借助代码去抓取想要的数据并进行可视化剖析是最方便灵活的,但是好多产品和营运说到学代码,可能马上就舍弃了。

那么有没有不懂代码就可以实现抓取数据,进行可视化剖析的方式呢?以下就是我为你们推荐的三款工具:

优采云可以比较容易的从网页精确采集你须要的数据,内容涵括电商类、生活服务类、社交媒体类、论坛类。

**▎优采云采集器优点:

●操作简单,完全可视化图形操作,无需专业IT人员,任何会使用笔记本上网的人都可以轻松把握。

●采集任务手动分配到云端多台服务器同时执行,提高采集效率,可以挺短的时间内 获取成千上万条信息。

●模拟人的操作思维模式,可以登录,输入数据,点击链接,按钮等,还能对不同情况采取不同的采集流程。

●内置可扩充的OCR插口,支持解析图片中的文字,可将图片上的文字提取下来。

●采集任务手动运行,可以根据指定的周期手动采集,并且还支持最快一分钟一次的实时采集。

●内置从入门到精通所须要的视频教程,2分钟才能上手使用,另外还有文档,论坛,qq群等。

**▎优采云采集器缺点:

●它又免费版本,当时好多功能须要付费或则积分。

●大量采集数据的时侯,容易出现采集不全的情况。

●判断语录较弱,无法进行复杂判定,也未能执行复杂逻辑。

image

优采云采集器组建的比较久,经过了十几年的迭代,可以实现抓取、清洗、分析,挖掘及最终的可用数据呈现,一整套服务。

▎优采云采集器优点:

●采集原理是基于 web 结构的源代码提取,几乎适用于所有的网页,以及网页中才能见到的所有内容;

●支持插口和插件多种扩充延展,满足愈发多元化的使用需求,使优采云采集器真正做到全网通用。

●在每位功能上都做了优化设置,除了最基础的数据采集,更是融入了强悍的数据处理和数据发布功能,全面建立了对于数据借助的整个流程。

●优采云采集器在许多细节操作中配置多项可选形式。

●分布式高速采集系统,占用资源少。

●实时地监控采集,数据不易遗漏。

▎优采云采集器缺点:

●规则配置繁杂。

●比较占用显存和CPU资源,大批量采集速度不行,资源回收控制得不好。

●高级功能必须付费版能够使用。

image

Tableau是数据可视化做的最好的平台之一,功能非常强悍。

▎Tableau 优点:

●优秀的数据可视化展示疗效,数据图表制做能力强

●操作简单,上手快不需要写代码,数据的导出和加载都是向导式

●内置美观的可视化图表,不用考虑配色,表格处理好格式即可。

▎Tableau 缺点:

●基于数据查询的工具,难以处理不规范数据,难以转化复杂模型。

●对输入数据类型有要求,运行上去比较慢,且只能支持PC笔记本,这也是好多Newsroom后来抛弃它的诱因。

●本身没有前端数据库房,宣称自己是显存BI,实际用上去对硬件要求极高,对于超千万条的数据剖析,必须借助于其他ETL工具处理好数据再进行后端剖析

●无法支持中国式复杂表样

●本地化服务差

●价格高昂

image

由此可见,工具有很多优点,但也有局限,对于有大量数据需求以及比较复杂的需求时侯还是须要通过代码实现,建议感兴趣的产品和营运可以稍稍了解下 python 。

image

以上,就是我对深度优先与广度优先的遍历算法的个人理解以及部份推荐的三个工具,大数据时代的到来,对数据爬取的需求越来越大,让我们一起学习上去。

如何用爬虫软件(如优采云采集器)完整地爬取亚马逊商品

采集交流 • 优采云 发表了文章 • 0 个评论 • 313 次浏览 • 2020-08-11 04:04

一般都是订单数据吧,可以用 博 为的小帮软件机器人采集,只须要设置一下采集的数组,比如说,姓名, 订单号,金额,物流号等,配置完成,以后流程可以手动运行,自动采集数据,方便的太。

亚马逊要采集什么。

我想批量采集亚马逊的商品图片,有哪些软件可以用。

电商图片助手可以采集,性能稳定,操作便捷,一键批量采集亚马逊的图片。

有哪些亚马逊跟卖采集软件可以采集商品的吗。

电商图片助手,可以一键采集亚马逊的商品图片和视频。

如何用爬虫软件(如优采云采集器)完整地爬取亚马逊商品。

您用前嗅爬虫试试,我之前是用它采集的亚马逊的商品评论,和商品信息是一样的,操作很简单,都是可视化的操作,按照教程一步步走就可以了,而且多复杂的页面他都能采集。

亚马逊采集软件有哪些作用。

酷鸟选品采集功能还能帮助买家实现:快速采集,亚马逊前台商品数据买家可通过亚马逊官网的搜索方法搜索到想要的商品,再依照两侧栏的条件搜索栏,选择您想要筛选的条件,然后把最后结果页的地址,复制到酷鸟的采集地址中,系统立即开始采集商品数据。

作用:一次性采集大批量数据,持续跟踪亚马逊上任何竞品及变体,观测价钱、卖家数目、评论数目等核心数据的趋势变化。

如何采集亚马逊店面宝贝。

电商图片助手,复制亚马逊宝贝链接,就可以一键批量下载宝贝图片和视频。

优采云亚马逊产品数据采集 是网页采集还是API采集。

举一款爬虫来说,集搜客网络爬虫是通过标明网页内容的形式来制订采集过程,其实在标明的过程中就是对网页内容的解析过程,程序手动会生成采集的规则(即方式),之后通过触发动作运行程序,数据自然就抓取出来了。

不管是采集亚马逊还是某宝上的产品数据,网络爬虫都是要将源文件里头的内容先解析下来,只不过这个解析的过程你看不见而已。

如何采集亚马逊listing垃圾。

伯爵云可以采集亚马逊listing垃圾,数据下载清晰完整,官网有试用版。 查看全部

大家都在用哪些亚马逊数据采集软件。

一般都是订单数据吧,可以用 博 为的小帮软件机器人采集,只须要设置一下采集的数组,比如说,姓名, 订单号,金额,物流号等,配置完成,以后流程可以手动运行,自动采集数据,方便的太。

亚马逊要采集什么。

我想批量采集亚马逊的商品图片,有哪些软件可以用。

电商图片助手可以采集,性能稳定,操作便捷,一键批量采集亚马逊的图片。

有哪些亚马逊跟卖采集软件可以采集商品的吗。

电商图片助手,可以一键采集亚马逊的商品图片和视频。

如何用爬虫软件(如优采云采集器)完整地爬取亚马逊商品。

您用前嗅爬虫试试,我之前是用它采集的亚马逊的商品评论,和商品信息是一样的,操作很简单,都是可视化的操作,按照教程一步步走就可以了,而且多复杂的页面他都能采集。

亚马逊采集软件有哪些作用。

酷鸟选品采集功能还能帮助买家实现:快速采集,亚马逊前台商品数据买家可通过亚马逊官网的搜索方法搜索到想要的商品,再依照两侧栏的条件搜索栏,选择您想要筛选的条件,然后把最后结果页的地址,复制到酷鸟的采集地址中,系统立即开始采集商品数据。

作用:一次性采集大批量数据,持续跟踪亚马逊上任何竞品及变体,观测价钱、卖家数目、评论数目等核心数据的趋势变化。

如何采集亚马逊店面宝贝。

电商图片助手,复制亚马逊宝贝链接,就可以一键批量下载宝贝图片和视频。

优采云亚马逊产品数据采集 是网页采集还是API采集。

举一款爬虫来说,集搜客网络爬虫是通过标明网页内容的形式来制订采集过程,其实在标明的过程中就是对网页内容的解析过程,程序手动会生成采集的规则(即方式),之后通过触发动作运行程序,数据自然就抓取出来了。

不管是采集亚马逊还是某宝上的产品数据,网络爬虫都是要将源文件里头的内容先解析下来,只不过这个解析的过程你看不见而已。

如何采集亚马逊listing垃圾。

伯爵云可以采集亚马逊listing垃圾,数据下载清晰完整,官网有试用版。

网站优化算法:飓风算法3.0,控制跨领域采集及站群问题

采集交流 • 优采云 发表了文章 • 0 个评论 • 317 次浏览 • 2020-08-10 20:20

我们先来详尽看下,百度官方剖析:

为了维护健康的联通生态,保障用户体验,保证优质站点/智能小程序才能获得合理的流量分发,百度搜索将在近日对飓风算法进行升级,上线飓风算法3.0。

本次算法升级主要针对跨领域采集以及站群问题,将覆盖百度搜索下的PC站点、H5站点、智能小程序等内容。对于算法覆盖的站点/智能小程序,将会依照违法问题的恶劣程度,酌情限制搜索结果的彰显。

以下详尽说明飓风算法3.0的相关规则。

一. 跨领域采集:

指站点/智能小程序为了获取更多流量,发布不属于站点/智能小程序领域范围的内容,通常这种内容采集自互联网,内容质量及相关性低、对搜索用户价值低。对于这样的行为搜索会判断该站点/智能小程序的领域专注度不足,会有不同程度的限制凸显。

跨领域采集主要包括下边两类问题:

第一类:主站或主页的内容/标题/关键词/摘要等信息显示该站有明晰的领域或行业,但发布内容与该领域不相关,或相关性较低。

问题示例:美食类智能小程序发布篮球相关内容

第二类:站点/智能小程序没有明晰的领域或行业,内容涉及多个领域或行业,领域模糊、领域专注度低。

问题示例:智能小程序内容涉及多个领域

二. 站群问题:

指批量构造多个站点/智能小程序,获取搜索流量的行为。站群中的站点/智能小程序大多质量低、资源稀缺性低、内容相似度高、甚至复用相同模板,难以满足搜索用户的需求。

问题示例:多个智能小程序复用同一模板,内容重复度高、内容少且内容稀缺性低

以上就是飓风算法3.0的相关说明,算法预计在8月内相继上线。请你们及时查收站内信、短信等渠道的提醒,积极自查完成整改,避免不必要的损失。

丹若科技针对个别站点,由于不相关信息多的站点,明显能感觉到,搜索的排行是在增长的。现在不在是流量为王的时代了,你的站点流量多,可能不能带有有效的转化,现在是精准流量的时代,你要和你相关的信息,给予相关的人帮助,对页面的转化来说是越来越重要的。在这个信息猖獗的时代,有效的信息将会愈发重要。 查看全部

小编详尽剖析了一下这次飓风算法,主要是针对猖獗的引流,和不想管的内容引流进行一个纠正。现在太多借助热点进行引流了,结果都是不相关的信息。导致用户的黏度不高,流失率高。对站点质量下滑。

我们先来详尽看下,百度官方剖析:

为了维护健康的联通生态,保障用户体验,保证优质站点/智能小程序才能获得合理的流量分发,百度搜索将在近日对飓风算法进行升级,上线飓风算法3.0。

本次算法升级主要针对跨领域采集以及站群问题,将覆盖百度搜索下的PC站点、H5站点、智能小程序等内容。对于算法覆盖的站点/智能小程序,将会依照违法问题的恶劣程度,酌情限制搜索结果的彰显。

以下详尽说明飓风算法3.0的相关规则。

一. 跨领域采集:

指站点/智能小程序为了获取更多流量,发布不属于站点/智能小程序领域范围的内容,通常这种内容采集自互联网,内容质量及相关性低、对搜索用户价值低。对于这样的行为搜索会判断该站点/智能小程序的领域专注度不足,会有不同程度的限制凸显。

跨领域采集主要包括下边两类问题:

第一类:主站或主页的内容/标题/关键词/摘要等信息显示该站有明晰的领域或行业,但发布内容与该领域不相关,或相关性较低。

问题示例:美食类智能小程序发布篮球相关内容

第二类:站点/智能小程序没有明晰的领域或行业,内容涉及多个领域或行业,领域模糊、领域专注度低。

问题示例:智能小程序内容涉及多个领域

二. 站群问题:

指批量构造多个站点/智能小程序,获取搜索流量的行为。站群中的站点/智能小程序大多质量低、资源稀缺性低、内容相似度高、甚至复用相同模板,难以满足搜索用户的需求。

问题示例:多个智能小程序复用同一模板,内容重复度高、内容少且内容稀缺性低

以上就是飓风算法3.0的相关说明,算法预计在8月内相继上线。请你们及时查收站内信、短信等渠道的提醒,积极自查完成整改,避免不必要的损失。

丹若科技针对个别站点,由于不相关信息多的站点,明显能感觉到,搜索的排行是在增长的。现在不在是流量为王的时代了,你的站点流量多,可能不能带有有效的转化,现在是精准流量的时代,你要和你相关的信息,给予相关的人帮助,对页面的转化来说是越来越重要的。在这个信息猖獗的时代,有效的信息将会愈发重要。

优采云采集器(www.ucaiyun.com)下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 653 次浏览 • 2020-08-10 16:21

优采云采集器(www.ucaiyun.com)下载

版本:v9.5

【软件介绍】

优采云采集器(www.ucaiyun.com)是一款专业的功能强悍的网路数据/信息挖掘软件,通过灵活的配置,您可以太轻松的从网页上抓取文字、图片、文件等任何资源。

程序支持远程下载图片文件,支持网站登陆后的信息采集,支持侦测文件真实地址,支持代理,支持防盗链的采集,支持采集数据直接入库和模仿人手工发布等许多功能特性。

优采云采集器支持从任何类型的网站采集获取您所须要的信息,如各类新闻类网站、论坛、电子商务网站、求职急聘网站等。

同时具有强悍的网站登录采集、多页和分页的采集、网站跨层采集、POST采集、脚本页面采集、动态页面采集等中级采集功能。

强大的php和c#插件支持,让您可以通过二次开发实现您所想要的任何更强大的功能。

【软件特色】

1、通用性强

无论新闻、论坛、视频、黄页、图片、下载类网站,只要通过浏览器能看到的结构化的内容,通过指定匹配规则,都能采集到您所须要的内容。

2、稳定、高效

五年磨一剑,软件不断更新进步,采集速度快,性能稳定,占用资源少。

3、扩展性强、适用范围广

自定义web发布,自定义主流的数据库的保存和发布,自定义本地php及.net外部编程插口处理数据,让数据都能为你所用。

基本功能

1、规则自定义 - 通过采集规则的定义,可以搜索所有网站采集几乎任何类型的信息。

2、多任务,多线程 - 可以同时进行多个信息采集任务,每个任务可以使用多个线程。

3、所见即所得 - 任务采集过程所见即所得,过程中遍历的链接信息、采集信息、错误信息等就会及时的反映在软件界面中。

4、数据保存 - 数据边采集边手动保存到关系数据库中,并且数据结构才能手动适应,软件可以依据采集规则手动创建数据库,以及其中的表和数组,也可以通过导库形式灵活的将数据保存到顾客已有的数据库结构中。

5、断点续采 - 信息采集任务可以在停止后从断点开始继续采集,从此你用不再害怕你的采集任务意外中断了。

6、网站登录 - 支持网站Cookie,支持网站可视化登陆,即使登陆时须要验证码的网站也能采集。

7、计划任务 - 通过这个功能可以使你的采集任务定时、定量或则始终循环执行。

8、采集范围限制 - 可以依据采集的深度和网址的标示来限制采集的范围。

9、文件下载 - 可以将采集到的二进制文件(诸如:图片、音乐、软件、文档等等)下载到本地c盘或则采集结果数据库中。

10、结果替换 - 可以将采集的结果按照规则替换成你定义的内容。

11、条件保存 - 可以按照某个条件来决定这些信息保存,那些信息过滤。

12、过滤重复内容 - 软件可依据用户设置和实际情况对重复内容和重复网址手动删掉重复内容。

13、特殊链接辨识 - 运用此功能可以将用JavaScript动态生成的链接或其他更奇特的联接辨识下来。

14、数据发布 - 可以通过自定义插口,将已采集的结果数据发布到任意的内容管理系统和指定数据库中。现在已支持的目标发布媒体包括:数据库(access, sql server,my sql,oracle) ,静态htm文件。

15、预留编程插口 - 定义多个编程插口,用户可以在风波中借助PHP,C#语言进行编程,扩充采集功能。

【软件功能】

1、支持所有网站编码:完美支持采集所有编码格式的网页,程序还可以手动辨识网页编码。

2、多种发布形式:支持目前所有主流和非主流的CMS,BBS等网站程序,通过系统的发布模块能实现采集器和网站程序间的完美结合。

3、全手动:无人值守工作,配置好程序后,程序将根据您的设置手动运行,完全无需人工干预。 查看全部

优采云采集器(www.ucaiyun.com)下载

版本:v9.5

【软件介绍】

优采云采集器(www.ucaiyun.com)是一款专业的功能强悍的网路数据/信息挖掘软件,通过灵活的配置,您可以太轻松的从网页上抓取文字、图片、文件等任何资源。

程序支持远程下载图片文件,支持网站登陆后的信息采集,支持侦测文件真实地址,支持代理,支持防盗链的采集,支持采集数据直接入库和模仿人手工发布等许多功能特性。

优采云采集器支持从任何类型的网站采集获取您所须要的信息,如各类新闻类网站、论坛、电子商务网站、求职急聘网站等。

同时具有强悍的网站登录采集、多页和分页的采集、网站跨层采集、POST采集、脚本页面采集、动态页面采集等中级采集功能。

强大的php和c#插件支持,让您可以通过二次开发实现您所想要的任何更强大的功能。

【软件特色】

1、通用性强

无论新闻、论坛、视频、黄页、图片、下载类网站,只要通过浏览器能看到的结构化的内容,通过指定匹配规则,都能采集到您所须要的内容。

2、稳定、高效

五年磨一剑,软件不断更新进步,采集速度快,性能稳定,占用资源少。

3、扩展性强、适用范围广

自定义web发布,自定义主流的数据库的保存和发布,自定义本地php及.net外部编程插口处理数据,让数据都能为你所用。

基本功能

1、规则自定义 - 通过采集规则的定义,可以搜索所有网站采集几乎任何类型的信息。

2、多任务,多线程 - 可以同时进行多个信息采集任务,每个任务可以使用多个线程。

3、所见即所得 - 任务采集过程所见即所得,过程中遍历的链接信息、采集信息、错误信息等就会及时的反映在软件界面中。

4、数据保存 - 数据边采集边手动保存到关系数据库中,并且数据结构才能手动适应,软件可以依据采集规则手动创建数据库,以及其中的表和数组,也可以通过导库形式灵活的将数据保存到顾客已有的数据库结构中。

5、断点续采 - 信息采集任务可以在停止后从断点开始继续采集,从此你用不再害怕你的采集任务意外中断了。

6、网站登录 - 支持网站Cookie,支持网站可视化登陆,即使登陆时须要验证码的网站也能采集。

7、计划任务 - 通过这个功能可以使你的采集任务定时、定量或则始终循环执行。

8、采集范围限制 - 可以依据采集的深度和网址的标示来限制采集的范围。

9、文件下载 - 可以将采集到的二进制文件(诸如:图片、音乐、软件、文档等等)下载到本地c盘或则采集结果数据库中。

10、结果替换 - 可以将采集的结果按照规则替换成你定义的内容。

11、条件保存 - 可以按照某个条件来决定这些信息保存,那些信息过滤。

12、过滤重复内容 - 软件可依据用户设置和实际情况对重复内容和重复网址手动删掉重复内容。

13、特殊链接辨识 - 运用此功能可以将用JavaScript动态生成的链接或其他更奇特的联接辨识下来。

14、数据发布 - 可以通过自定义插口,将已采集的结果数据发布到任意的内容管理系统和指定数据库中。现在已支持的目标发布媒体包括:数据库(access, sql server,my sql,oracle) ,静态htm文件。

15、预留编程插口 - 定义多个编程插口,用户可以在风波中借助PHP,C#语言进行编程,扩充采集功能。

【软件功能】

1、支持所有网站编码:完美支持采集所有编码格式的网页,程序还可以手动辨识网页编码。

2、多种发布形式:支持目前所有主流和非主流的CMS,BBS等网站程序,通过系统的发布模块能实现采集器和网站程序间的完美结合。

3、全手动:无人值守工作,配置好程序后,程序将根据您的设置手动运行,完全无需人工干预。

【大数据工具】国内外大数据采集工具基础介绍

采集交流 • 优采云 发表了文章 • 0 个评论 • 469 次浏览 • 2020-08-10 07:40

工欲善其事,必先利其器。众多新的软件剖析工具作为深入大数据洞察研究的重要推动, 也成为数据科学家所必须把握的知识技能。

然而,现实情况的复杂性决定了并不存在解决一切问题的终极工具。实际研究过程中,需要按照实际情况灵活选择最合适的工具(甚至多种工具组合使用),才能更好的完成研究探求。

为此,本文针对研究人员(非技术人员)的实际情况,介绍当前大数据研究涉及的一些主要工具软件。

1、传统剖析/商业统计

Excel、SPSS、SAS 这两者对于研究人员而言并不陌生。

Excel作为电子表格软件,适合简单统计(分组/求和等)需求,由于其便捷好用,功能也能满足好多场景须要,所以实际成为研究人员最常用的软件工具。其缺点在于功能单一,且可处理数据规模小(这一点使好多研究人员尤为头晕)。这三年Excel在大数据方面(如地理可视化和网路关系剖析)上也做出了一些提高,但应用能力有限。

SPSS(SPSS Statistics)和SAS作为商业统计软件,提供研究常用的精典统计剖析(如回归、方差、因子、多变量分析等)处理。

SPSS轻量、易于使用,但功能相对较少,适合常规基本统计剖析SAS功能丰富而强悍(包括绘图能力),且支持编程扩充其剖析能力,适合复杂与高要求的统计性剖析。上述三个软件在面对大数据环境出现了各类不适,具体不再赘言。但这并不代表其没有使用价值。如果使用传统研究方法论剖析大数据时,海量原创数据资源经过前期处理(如聚类和统计汇总等)得到的中间研究结果,就太适宜使用它们进行进一步研究。

2、数据挖掘

数据挖掘作为大数据应用的重要领域,在传统统计剖析基础上,更指出提供机器学习的方式,关注高维空间下复杂数据关联关系和推演能力。代表是SPSS Modeler(注意不是SPSS Statistics,其前身为Clementine)

SPSS Modeler的统计功能相对有限, 主要是提供面向商业挖掘的机器学习算法(决策树、神经元网路、分类、聚类和预测等)的实现。同时,其数据预处理和结果辅助剖析方面也相当便捷,这一点尤其适宜商业环境下的快速挖掘。不过就处理能力而言,实际觉得无法应对亿级以上的数据规模。

另一个商业软件 Matlab也能提供大量数据挖掘的算法,但其特点更关注科学与工程估算领域。而着名的开源数据挖掘软件Weka,功能较少,且数据预处理和结果剖析也比较麻烦,更适宜学术界或有数据预处理能力的使用者。

国内的大数据商业软件有例如优采云采集器之类功能丰富,插件齐全的大数据采集工具。

优采云采集器(www.ucaiyun.com) 是一个供各大主流文章系统,论坛系统等使用的多线程内容采集发布程序。使用优采云采集器,你可以顿时构建一个拥有庞大内容的网站。系统支持远程图片下载,图片批量水印,Flash下载,下载文件地址侦测,自制做发表的cms模块参数,自定义发表的内容等有关采集器。对于数据的采集其可以分为两部份,一是采集数据,二是发布数据。

功能特性:

1采集功能健全且不限网页与内容,任意文件格式都可下载

2具有智能多辨识系统以及可选的验证方法保护安全

3支持PHP和C#插件扩充,方便更改处理数据

4具有同义,近义词替换、参数替换,伪原创必备技能 查看全部

如今,大数据日渐成为研究行业的重要研究目标。面对其高数据量、多维度与异构化的特性,以及剖析方式思路的扩充,传统统计工具已然无法应对。

工欲善其事,必先利其器。众多新的软件剖析工具作为深入大数据洞察研究的重要推动, 也成为数据科学家所必须把握的知识技能。

然而,现实情况的复杂性决定了并不存在解决一切问题的终极工具。实际研究过程中,需要按照实际情况灵活选择最合适的工具(甚至多种工具组合使用),才能更好的完成研究探求。

为此,本文针对研究人员(非技术人员)的实际情况,介绍当前大数据研究涉及的一些主要工具软件。

1、传统剖析/商业统计

Excel、SPSS、SAS 这两者对于研究人员而言并不陌生。

Excel作为电子表格软件,适合简单统计(分组/求和等)需求,由于其便捷好用,功能也能满足好多场景须要,所以实际成为研究人员最常用的软件工具。其缺点在于功能单一,且可处理数据规模小(这一点使好多研究人员尤为头晕)。这三年Excel在大数据方面(如地理可视化和网路关系剖析)上也做出了一些提高,但应用能力有限。

SPSS(SPSS Statistics)和SAS作为商业统计软件,提供研究常用的精典统计剖析(如回归、方差、因子、多变量分析等)处理。

SPSS轻量、易于使用,但功能相对较少,适合常规基本统计剖析SAS功能丰富而强悍(包括绘图能力),且支持编程扩充其剖析能力,适合复杂与高要求的统计性剖析。上述三个软件在面对大数据环境出现了各类不适,具体不再赘言。但这并不代表其没有使用价值。如果使用传统研究方法论剖析大数据时,海量原创数据资源经过前期处理(如聚类和统计汇总等)得到的中间研究结果,就太适宜使用它们进行进一步研究。

2、数据挖掘

数据挖掘作为大数据应用的重要领域,在传统统计剖析基础上,更指出提供机器学习的方式,关注高维空间下复杂数据关联关系和推演能力。代表是SPSS Modeler(注意不是SPSS Statistics,其前身为Clementine)

SPSS Modeler的统计功能相对有限, 主要是提供面向商业挖掘的机器学习算法(决策树、神经元网路、分类、聚类和预测等)的实现。同时,其数据预处理和结果辅助剖析方面也相当便捷,这一点尤其适宜商业环境下的快速挖掘。不过就处理能力而言,实际觉得无法应对亿级以上的数据规模。

另一个商业软件 Matlab也能提供大量数据挖掘的算法,但其特点更关注科学与工程估算领域。而着名的开源数据挖掘软件Weka,功能较少,且数据预处理和结果剖析也比较麻烦,更适宜学术界或有数据预处理能力的使用者。

国内的大数据商业软件有例如优采云采集器之类功能丰富,插件齐全的大数据采集工具。

优采云采集器(www.ucaiyun.com) 是一个供各大主流文章系统,论坛系统等使用的多线程内容采集发布程序。使用优采云采集器,你可以顿时构建一个拥有庞大内容的网站。系统支持远程图片下载,图片批量水印,Flash下载,下载文件地址侦测,自制做发表的cms模块参数,自定义发表的内容等有关采集器。对于数据的采集其可以分为两部份,一是采集数据,二是发布数据。

功能特性:

1采集功能健全且不限网页与内容,任意文件格式都可下载

2具有智能多辨识系统以及可选的验证方法保护安全

3支持PHP和C#插件扩充,方便更改处理数据

4具有同义,近义词替换、参数替换,伪原创必备技能

深维全能信息采集软件

采集交流 • 优采云 发表了文章 • 0 个评论 • 368 次浏览 • 2020-08-10 05:14

使用说明该软件为红色破解版,免安装、免注册,运行软件可以看见早已注册成功功能特性1、强大的信息采集功能

可采集几乎任何类型的网站信息,包括静态htm,html类型和动态ASP,ASPX,JSP等。可N级页面采集。可手动下载二进制文件,比如图片,软件,mp3等。

2、网站登录

需要登入能够看见的信息,先在任务的’登录设置’处进行登陆,就可采集登录后就能看见的信息。

3、速度快,运行稳定

真正的多线程,多任务,运行时占用系统资源甚少,可稳定地长时间运行。(明显区别于其他软件)

4、数据保存格式丰富

可把采集的数据,保存为Txt,Excel和多种数据库格式(Access sqlserver Oracle Mysql等)。

5、强大的新闻采集,自动化处理功能

可手动保留新闻的格式,包括图片等。可通过设置,自动下载图片 ,自动把正文里图片的网路路径改为本地文件路径(也可保留原貌);可把采集的新闻手动处理成自己设计的模板格式;可采集具有分页方式的新闻。通过这种功能,简单设置后即可在本地构建一个强悍的新闻系统,无需人工干预。

6、强大的信息手动再加工功能

对采集的信息,可进行二次批量再加工,使之愈加符合您的实际要求。也可设置手动加工公式,在采集的过程中,按照公式手动加工处理,包括数据合并和数据替换等。应用亮点1、通用:根据拟定采集规则,可以采集任何通过浏览器看得到的东西;

2、灵活:支持网站登录采集、网站跨层采集、POST采集、脚本采集、动态页面采集等中级功能;

3、扩展性强:支持存储过程、插件等,可由用户自由扩充功能,进行二次开发;

4、高效:为了使用户节约一分钟去做其它事情,软件做了悉心设计;

5、速度快:速度最快、效率最高的采集软件;

6、稳定:系统资源占用少、有详尽的运行报告、采集性能稳定;

7、人性化:注重软件细节、强调人性化体验。 查看全部

深维全能信息采集软件是一款便捷且实用的自助式网路信息采集、监控软件,基于多年从事网路信息采集软件开发的经验和成果而制做,非常适用于网站信息采集的站长工具,同步支持网站跨层采集、POST采集、脚本采集、网站登录采集、动态页面采集等功能,面向国外广大的市场,以最先进的技术服务于国外用户。该软件是自助图形化的配置工具,采用了交互式的策略、先进的机器学习算法,让您的配置操作得以简化,无论是谁在几分钟的时间上面都可以完全的把握该软件,并且支持对非结构化的文本数据进行保存,支持用户名密码手动登入、自动参数递交、自动翻页、自动生成模板等多种功能,可以完整、准确地采集各种静态页面、动态页面、文件和数据库,对于采集到的数据,可以通过该系统提供的插口,方便地实现与其他系统的集成应用。对于往年的采集软件来说,往往须要复杂的配置操作能够工作,导致用户不能精确配置和更改采集内容,并最终造成软件系统不能正常使用,而深维全能信息采集软件则专门开发了自助图形化配置工具,采用交互式策略和机器学习算法,极大简化了配置操作,普通用户几分钟内即可学习把握,通过简单的配置,即可将所采集网页中的非结构化文本数据保存为结构化的数据。

使用说明该软件为红色破解版,免安装、免注册,运行软件可以看见早已注册成功功能特性1、强大的信息采集功能

可采集几乎任何类型的网站信息,包括静态htm,html类型和动态ASP,ASPX,JSP等。可N级页面采集。可手动下载二进制文件,比如图片,软件,mp3等。

2、网站登录

需要登入能够看见的信息,先在任务的’登录设置’处进行登陆,就可采集登录后就能看见的信息。

3、速度快,运行稳定

真正的多线程,多任务,运行时占用系统资源甚少,可稳定地长时间运行。(明显区别于其他软件)

4、数据保存格式丰富

可把采集的数据,保存为Txt,Excel和多种数据库格式(Access sqlserver Oracle Mysql等)。

5、强大的新闻采集,自动化处理功能

可手动保留新闻的格式,包括图片等。可通过设置,自动下载图片 ,自动把正文里图片的网路路径改为本地文件路径(也可保留原貌);可把采集的新闻手动处理成自己设计的模板格式;可采集具有分页方式的新闻。通过这种功能,简单设置后即可在本地构建一个强悍的新闻系统,无需人工干预。

6、强大的信息手动再加工功能

对采集的信息,可进行二次批量再加工,使之愈加符合您的实际要求。也可设置手动加工公式,在采集的过程中,按照公式手动加工处理,包括数据合并和数据替换等。应用亮点1、通用:根据拟定采集规则,可以采集任何通过浏览器看得到的东西;

2、灵活:支持网站登录采集、网站跨层采集、POST采集、脚本采集、动态页面采集等中级功能;

3、扩展性强:支持存储过程、插件等,可由用户自由扩充功能,进行二次开发;

4、高效:为了使用户节约一分钟去做其它事情,软件做了悉心设计;

5、速度快:速度最快、效率最高的采集软件;

6、稳定:系统资源占用少、有详尽的运行报告、采集性能稳定;

7、人性化:注重软件细节、强调人性化体验。

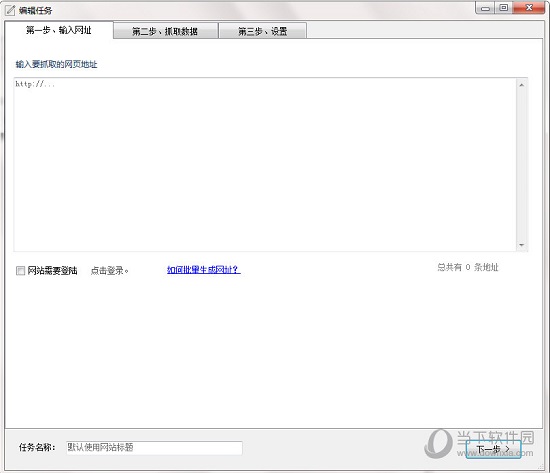

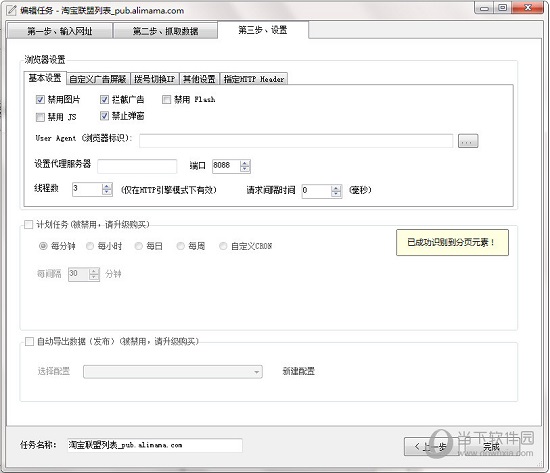

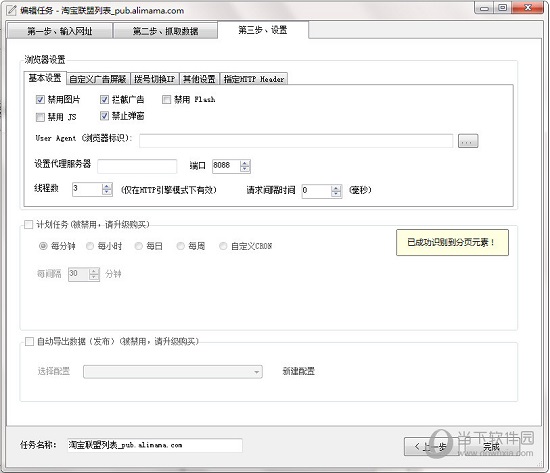

优采云采集器 V2.1.8.0 官方版最新无限制破解版测试可用[联网软件]

采集交流 • 优采云 发表了文章 • 0 个评论 • 385 次浏览 • 2020-08-10 05:06

【软件特色】

一键提取数据

简单易学,通过可视化界面,鼠标点击即可抓取数据

快速高效

内置一套高速浏览器内核,加上HTTP引擎模式,实现快速采集数据

适用各类网站

能够采集互联网99%的网站,包括单页应用Ajax加载等等动态类型网站

【功能介绍】

向导模式

简单易用,轻松通过滑鼠点击手动生成

脚本定时运行

可依照计划定时运行,无需人工

独创高速内核

自研的浏览器内核,速度飞快,远超对手

智能辨识

对于网页中的列表、表单结构(多选框下拉列表等)能够智能辨识

广告屏蔽

定制的广告屏蔽模块,兼容AdblockPlus句型,可添加自定义规则

多种数据导入

支持Txt 、Excel、MySQL、SQLServer、SQlite、Access、网站等

【使用流程】

输入采集网址

打开软件,新建任务,输入须要采集的网站地址。

智能剖析,全程自动化提取数据

进入到第二步后,优采云采集器全手动智能剖析网页,并且从中提取出列表数据。

导出数据到表格、数据库、网站等

运行任务,将采集到的数据导入为Csv、Excel以及各类数据库,支持api导入。

【常见问题】

问:如何过滤列表中的前N个数据?

1、有时我们须要对采集到的列表进行过滤,比如过滤掉第一组数据(在采集表格时,过滤掉表格列名)

2、点击列表模式菜单中的,设置列表xpath

问:如何抓包获取Cookie,并且自动设置?

1、首先,使用谷歌浏览器打开要采集的网站,并且登入。

2、然后按下 F12,会出现开发者工具,选择 Network

3、然后按下F5,刷新下页面, 选择其中一个恳求。

4、复制完成后,在优采云采集器中,编辑任务,进入第三步,指定HTTP Header。

【更新日志】

V2.1.8.0

1、增加插件功能

2、增加导入 txt (一条保存为一个文件)

3、多值连接符支持换行符

4、修改数据处理的文本映射(支持查找替换)

5、修复登录时的DNS问题

6、修复图片下载问题

7、修复 json 一些问题 查看全部

优采云采集器是一款新一代智能化的网页采集工具,智能剖析、可视化界面,一键采集无需编程,支持手动生成采集脚本,可以采集互联网99%的网站。软件简单易学,通过智能算法+可视化界面,随心所欲,抓取自己想到的数据。只要轻松点击滑鼠,就能采集网页上的数据。

【软件特色】

一键提取数据

简单易学,通过可视化界面,鼠标点击即可抓取数据

快速高效

内置一套高速浏览器内核,加上HTTP引擎模式,实现快速采集数据

适用各类网站

能够采集互联网99%的网站,包括单页应用Ajax加载等等动态类型网站

【功能介绍】

向导模式

简单易用,轻松通过滑鼠点击手动生成

脚本定时运行

可依照计划定时运行,无需人工

独创高速内核

自研的浏览器内核,速度飞快,远超对手

智能辨识

对于网页中的列表、表单结构(多选框下拉列表等)能够智能辨识

广告屏蔽

定制的广告屏蔽模块,兼容AdblockPlus句型,可添加自定义规则

多种数据导入

支持Txt 、Excel、MySQL、SQLServer、SQlite、Access、网站等

【使用流程】

输入采集网址

打开软件,新建任务,输入须要采集的网站地址。

智能剖析,全程自动化提取数据

进入到第二步后,优采云采集器全手动智能剖析网页,并且从中提取出列表数据。

导出数据到表格、数据库、网站等

运行任务,将采集到的数据导入为Csv、Excel以及各类数据库,支持api导入。

【常见问题】

问:如何过滤列表中的前N个数据?

1、有时我们须要对采集到的列表进行过滤,比如过滤掉第一组数据(在采集表格时,过滤掉表格列名)

2、点击列表模式菜单中的,设置列表xpath

问:如何抓包获取Cookie,并且自动设置?

1、首先,使用谷歌浏览器打开要采集的网站,并且登入。

2、然后按下 F12,会出现开发者工具,选择 Network

3、然后按下F5,刷新下页面, 选择其中一个恳求。

4、复制完成后,在优采云采集器中,编辑任务,进入第三步,指定HTTP Header。

【更新日志】

V2.1.8.0

1、增加插件功能

2、增加导入 txt (一条保存为一个文件)

3、多值连接符支持换行符

4、修改数据处理的文本映射(支持查找替换)

5、修复登录时的DNS问题

6、修复图片下载问题

7、修复 json 一些问题

SmartCamera 高性能单反实时采集识别框架, 支持算法可配置化调优

采集交流 • 优采云 发表了文章 • 0 个评论 • 330 次浏览 • 2020-08-17 01:53

English

SmartCamera 是一个 Android 相机拓展库,提供了一个高度可订制的实时扫描模块才能实时采集并且辨识单反内物体边框是否吻合指定区域。如果认为还不错,欢迎 star,fork。

语言描述上去略显生硬,具体实现的功能如下图所示,适用于身份证,名片,文档等内容的扫描、自动拍摄而且剪裁, 你也可以下载 apk 体验:

SmartCamera-Sample-debug.apk

在单反实现上,SmartCamera 以源码的形式引用了 Google 开源的 CameraView ,并且稍作更改以支持 Camera.PreviewCallback 回调来获取单反预览流。

SmartCameraView 继承于修改后的 CameraView,为其添加了一个选框遮罩视图( MaskView )和一个实时扫描模块( SmartScanner )。其中选框视图即是你听到的单反里面的那层选定框,并配备了一个由上到下的扫描疗效,当然你也可以实现 MaskViewImpl 接口来自定义选框视图。

实时扫描模块( SmartScanner )是本库的核心功能所在,配合单反 PreviewCallback 接口反弹的预览流和选框视图 MaskView 提供的选框区域 RectF,能以不错的性能实时判别出内容是否吻合选框。

你也可以关注我的另一个库 SmartCropper: 一个简单易用的智能图片剪裁库,适用于身份证,名片,文档等合照的剪裁。

扫描算法调优

SmartScanner 提供了丰富的算法配置,使用者可以自己更改扫描算法以获得更好的适配性,阅读附表一提供的各参数使用说明来获得更好的辨识疗效。

为了更方便、高效地调优算法,SmartScanner 贴心地为你提供了扫描预览模式,开启预览功能后,你可以通过 SmartScanner 获取每一帧处理的结果输出到 ImageView 中实时观察 native 层扫描的结果,其中白线区域即为边沿测量的结果,白线加粗区域即为辨识出的边框。

你的目标是通过调节 SmartScanner 的各个参数促使内容边界清晰可见,识别出的边框(白色加粗线段)准确无误。

注:SmartCamera 在各方面做了性能以及显存上的优化,但是出于不必要的性能资源浪费,算法参数调优结束后请关掉预览模式。

接入

1.根目录下的 build.gradle 添加:

allprojects {

repositories {

...

maven { url 'https://jitpack.io' }

}

}

2.添加依赖

dependencies {

implementation 'com.github.pqpo:SmartCamera:v1.0.0'

}

注意:由于使用了 JNI, 请防止混淆

-keep class me.pqpo.smartcameralib.**{*;}

使用1. 引入单反布局,并启动单反(必要时启动预览)

@Override

protected void onResume() {

super.onResume();

mCameraView.start();

mCameraView.startScan();

}

@Override

protected void onPause() {

mCameraView.stop();

super.onPause();

if (alertDialog != null) {

alertDialog.dismiss();

}

mCameraView.stopScan();

}

注:若开启了预览别忘了调用相应开启、结束预览的技巧。

2. 修改扫描模块参数(可选,调优算法,同时按第 4 步中开启预览模式)

扫描模块各个参数含义详见附录一

private void initScannerParams() {

SmartScanner.DEBUG = true;

SmartScanner.detectionRatio = 0.1f;

SmartScanner.checkMinLengthRatio = 0.8f;

SmartScanner.cannyThreshold1 = 20;

SmartScanner.cannyThreshold2 = 50;

SmartScanner.houghLinesThreshold = 130;

SmartScanner.houghLinesMinLineLength = 80;

SmartScanner.houghLinesMaxLineGap = 10;

SmartScanner.firstGaussianBlurRadius = 3;

SmartScanner.secondGaussianBlurRadius = 3;

SmartScanner.maxSize = 300;

SmartScanner.angleThreshold = 5;

// don't forget reload params

SmartScanner.reloadParams();

}

注: 修改参数后别忘掉通知 native 层重新加载参数:SmartScanner.reloadParams();

3. 配置遮罩选框视图(可选,若要更改默认的视图, 或要更改选框区域)

配置 MaskView 各个方法的含义详见附录二

final MaskView maskView = (MaskView) mCameraView.getMaskView();;

maskView.setMaskLineColor(0xff00adb5);

maskView.setShowScanLine(true);

maskView.setScanLineGradient(0xff00adb5, 0x0000adb5);

maskView.setMaskLineWidth(2);

maskView.setMaskRadius(5);

maskView.setScanSpeed(6);

maskView.setScanGradientSpread(80);

mCameraView.post(new Runnable() {

@Override

public void run() {

int width = mCameraView.getWidth();

int height = mCameraView.getHeight();

if (width < height) {

maskView.setMaskSize((int) (width * 0.6f), (int) (width * 0.6f / 0.63));

maskView.setMaskOffset(0, -(int)(width * 0.1));

} else {

maskView.setMaskSize((int) (width * 0.6f), (int) (width * 0.6f * 0.63));

}

}

});

mCameraView.setMaskView(maskView);

4. 配置 SmartCameraView1. 开启预览:

mCameraView.getSmartScanner().setPreview(true);

mCameraView.setOnScanResultListener(new SmartCameraView.OnScanResultListener() {

@Override

public boolean onScanResult(SmartCameraView smartCameraView, int result) {

Bitmap previewBitmap = smartCameraView.getPreviewBitmap();

if (previewBitmap != null) {

ivPreview.setImageBitmap(previewBitmap);

}

return false;

}

});

通过第一句代码开启了预览模式。

你可以通过 setOnScanResultListener 设置反弹获得每一帧的扫描结果,其中 result == 1 表示辨识结果吻合边框

若开启了预览模式,你可以在反弹中使用 smartCameraView.getPreviewBitmap() 方法获取每一帧处理的结果。

返回值为 false 表示不拦截扫描结果,这时 SmartCameraView 内部会在 result 为 1 的情况下手动触发照相,若你自己处理了扫描结果返回 true 即可。

2. 获取照相结果,并且剪裁选框区域:

mCameraView.addCallback(new CameraView.Callback() {

@Override

public void onPictureTaken(CameraView cameraView, byte[] data) {

super.onPictureTaken(cameraView, data);

// 异步裁剪图片

mCameraView.cropImage(data, new SmartCameraView.CropCallback() {

@Override

public void onCropped(Bitmap cropBitmap) {

if (cropBitmap != null) {

showPicture(cropBitmap);

}

}

);

}

});

获取照相结果的反弹是 CameraView 提供的,你只须要在内部调用 SmartCameraView 提供的 cropImage 方法即可获取选框区域内的剪裁图片

注:其他关于 SmartCameraView 的使用方式同 CameraView ,另外更具体的使用方式请参考 app 内代码

附录

见 github

感谢关于我: 查看全部

SmartCamera 高性能单反实时采集识别框架, 支持算法可配置化调优

English

SmartCamera 是一个 Android 相机拓展库,提供了一个高度可订制的实时扫描模块才能实时采集并且辨识单反内物体边框是否吻合指定区域。如果认为还不错,欢迎 star,fork。

语言描述上去略显生硬,具体实现的功能如下图所示,适用于身份证,名片,文档等内容的扫描、自动拍摄而且剪裁, 你也可以下载 apk 体验:

SmartCamera-Sample-debug.apk

在单反实现上,SmartCamera 以源码的形式引用了 Google 开源的 CameraView ,并且稍作更改以支持 Camera.PreviewCallback 回调来获取单反预览流。

SmartCameraView 继承于修改后的 CameraView,为其添加了一个选框遮罩视图( MaskView )和一个实时扫描模块( SmartScanner )。其中选框视图即是你听到的单反里面的那层选定框,并配备了一个由上到下的扫描疗效,当然你也可以实现 MaskViewImpl 接口来自定义选框视图。

实时扫描模块( SmartScanner )是本库的核心功能所在,配合单反 PreviewCallback 接口反弹的预览流和选框视图 MaskView 提供的选框区域 RectF,能以不错的性能实时判别出内容是否吻合选框。

你也可以关注我的另一个库 SmartCropper: 一个简单易用的智能图片剪裁库,适用于身份证,名片,文档等合照的剪裁。

扫描算法调优

SmartScanner 提供了丰富的算法配置,使用者可以自己更改扫描算法以获得更好的适配性,阅读附表一提供的各参数使用说明来获得更好的辨识疗效。

为了更方便、高效地调优算法,SmartScanner 贴心地为你提供了扫描预览模式,开启预览功能后,你可以通过 SmartScanner 获取每一帧处理的结果输出到 ImageView 中实时观察 native 层扫描的结果,其中白线区域即为边沿测量的结果,白线加粗区域即为辨识出的边框。

你的目标是通过调节 SmartScanner 的各个参数促使内容边界清晰可见,识别出的边框(白色加粗线段)准确无误。

注:SmartCamera 在各方面做了性能以及显存上的优化,但是出于不必要的性能资源浪费,算法参数调优结束后请关掉预览模式。

接入