网页视频抓取浏览器

网页视频抓取浏览器(跨境浏览器3.隔离网络和IP网络的关联因素有哪些?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-04-16 07:17

对于跨境电商来说,无论是亚马逊还是eBay还是Shopee。国内IP有时候很不方便,因为这些跨境平台对商家的政策非常严格。如果找到具有相同IP地址的商店,则将其关联并锁定。

这时,我们就需要一款能够提供有效、稳定、不同IP地址进行反关联的软件。

很久以前,我们用过各种云服务器,但是这些服务器都是在网络上标明的,亚马逊的反关联机制也能抓到。

跨境浏览器

所以为了账户安全,我们放弃了云服务器。并着手寻找更好的反关联工具。

对于网络IP地址的情况,我们选择跨境浏览器进行反关联测试。

经过测试,我得出以下结论。

1. 隔离账户之间的网络和IP

网络和IP之间的关系是一个众所周知的相关因素。电脑硬盘、网卡、路由器等都可能是判断账户关系的依据。指纹浏览器可以实现隔离网络的功能,简化你的账号和IP地址,从而在IP地址上实现一账号一IP的网络环境。

私下浏览

用户的使用习惯信息是亚马逊机器区分关联账户的重要信息。就是通过一个人的浏览习惯来判断每个账号是否由同一个人操作。指纹浏览器可配置独立指纹。这可以防止它被机器识别。

跨境浏览器

3. 模拟生态环境

当我们管理多个账户时,很容易忽视互联网环境的变化。如果我们疏忽,我们可能会登录到同一网络环境中的其他帐户。这种在同一环境下频繁更换账号的行为显然是很容易造成的。后台关注。

因此,防关联浏览器可以配置独立的IP,模拟相应的网络环境,增加防关联的安全性。相当不错! 查看全部

网页视频抓取浏览器(跨境浏览器3.隔离网络和IP网络的关联因素有哪些?)

对于跨境电商来说,无论是亚马逊还是eBay还是Shopee。国内IP有时候很不方便,因为这些跨境平台对商家的政策非常严格。如果找到具有相同IP地址的商店,则将其关联并锁定。

这时,我们就需要一款能够提供有效、稳定、不同IP地址进行反关联的软件。

很久以前,我们用过各种云服务器,但是这些服务器都是在网络上标明的,亚马逊的反关联机制也能抓到。

跨境浏览器

所以为了账户安全,我们放弃了云服务器。并着手寻找更好的反关联工具。

对于网络IP地址的情况,我们选择跨境浏览器进行反关联测试。

经过测试,我得出以下结论。

1. 隔离账户之间的网络和IP

网络和IP之间的关系是一个众所周知的相关因素。电脑硬盘、网卡、路由器等都可能是判断账户关系的依据。指纹浏览器可以实现隔离网络的功能,简化你的账号和IP地址,从而在IP地址上实现一账号一IP的网络环境。

私下浏览

用户的使用习惯信息是亚马逊机器区分关联账户的重要信息。就是通过一个人的浏览习惯来判断每个账号是否由同一个人操作。指纹浏览器可配置独立指纹。这可以防止它被机器识别。

跨境浏览器

3. 模拟生态环境

当我们管理多个账户时,很容易忽视互联网环境的变化。如果我们疏忽,我们可能会登录到同一网络环境中的其他帐户。这种在同一环境下频繁更换账号的行为显然是很容易造成的。后台关注。

因此,防关联浏览器可以配置独立的IP,模拟相应的网络环境,增加防关联的安全性。相当不错!

网页视频抓取浏览器(网页视频抓取浏览器分析工具提取app安装包上传appstore)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-04-14 16:04

网页视频抓取浏览器分析工具提取app安装包上传appstore网页图片抓取用网页视频抓取工具提取网页视频分析,解析,工具抓取自己手机的app,自己可以写后台,然后可以将分析后的数据上传appstore网页抓取,可以用beef,pagequant分析appstore图片,工具videolapi编程,可以自己写插件,工具freecodecamp网页截图工具自动抓取网页里的图片,工具:,工具:photomerge。

你首先要有网页。最便捷的方法就是弄个能随时请求网站服务的浏览器。不知道这两个网站实例有没有很简单,反正我用了chrome挺好用的。

抓取方法很多,最简单的是使用autorespider,专业的话要看你的目标网站有多复杂的接口,抓取工具也有很多,比如广告联盟工具厂商开发的canweb,对于一些简单的网站效果还不错。有了网站之后,推荐你使用百度的开放平台的抓取插件(exchangedviewer)。

谷歌autorespider,

试试你。

我看有人说page123。这个真的做不到啊,可以考虑一下beef。

安利个效率神器:yicat!

没有合适的工具抓取到主页,后续分析需要一定功力。对于做aso优化的人来说,除了主流广告联盟,还可以通过第三方工具看看竞品app的历史广告展示监控、点击图片地址、重定向的代码等数据,整理出来后使用。 查看全部

网页视频抓取浏览器(网页视频抓取浏览器分析工具提取app安装包上传appstore)

网页视频抓取浏览器分析工具提取app安装包上传appstore网页图片抓取用网页视频抓取工具提取网页视频分析,解析,工具抓取自己手机的app,自己可以写后台,然后可以将分析后的数据上传appstore网页抓取,可以用beef,pagequant分析appstore图片,工具videolapi编程,可以自己写插件,工具freecodecamp网页截图工具自动抓取网页里的图片,工具:,工具:photomerge。

你首先要有网页。最便捷的方法就是弄个能随时请求网站服务的浏览器。不知道这两个网站实例有没有很简单,反正我用了chrome挺好用的。

抓取方法很多,最简单的是使用autorespider,专业的话要看你的目标网站有多复杂的接口,抓取工具也有很多,比如广告联盟工具厂商开发的canweb,对于一些简单的网站效果还不错。有了网站之后,推荐你使用百度的开放平台的抓取插件(exchangedviewer)。

谷歌autorespider,

试试你。

我看有人说page123。这个真的做不到啊,可以考虑一下beef。

安利个效率神器:yicat!

没有合适的工具抓取到主页,后续分析需要一定功力。对于做aso优化的人来说,除了主流广告联盟,还可以通过第三方工具看看竞品app的历史广告展示监控、点击图片地址、重定向的代码等数据,整理出来后使用。

网页视频抓取浏览器(网页视频抓取浏览器、h5、js网页标签都是什么呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-03-30 04:03

网页视频抓取浏览器、h5、js网页标签都是什么呢?你会不会被怎么会这么麻烦呢?虽然标签有许多,但是每一个标签都有相对应的作用。概念篇字体类型background、css3、text、font、box、block等background-disable属性background-color属性background-size属性background-repeat属性1.background-disablecss3background-repeat如果不设置background-repeat属性,则默认关闭文档中所有元素的background对象中的background属性。

如果允许你background-repeat设置它,则元素中的background-repeat对象将开启元素的background-repeat属性。如果任何其他元素创建一个background-repeat对象,则元素将开启snapshot-background属性。要检查元素中是否是使用snapshot-background-color设置元素的背景颜色,请检查元素中是否允许background-repeat设置exported。

2.background-colorcss3和standard都提供了background-color属性可供给浏览器或操作系统的底层以及浏览器内核使用。例如可以根据默认的background-color设置默认的background-repeat属性,或者默认的background-repeat设置background-color属性,包括:background-color:none(undercurrentcolor),undercurrentcolor(pre-renderedcolor),0(fullcolor),justify-content(0,100%),repeat-references(referencesoftheexportedbackground),point-aliasing(pointcolorforreferencesoftheexportedbackground),space-align-items(spacealignaxis)。

3.textborderborder-style属性是否允许monospace属性--css规范中关于text-border-style和monospace有明确的规定-text-border-style属性也许会有很多值,不过建议按照一些值设置,例如width和height,具体说如text-border-style-twonf和text-border-twoae等。

相信,有很多同学都曾阅读过这样的文章。实践篇看看不一样的网页视频抓取你在视频抓取的过程中,通常会遇到视频的采集、压缩、裁剪、水印等一系列的环节。首先,你将获取并解压视频文件://采集视频文件varwithinvideo=(function(parameters){//设置request方法的参数parameters.preload=function(cls){//抛弃srcset队列中的元素,解包后返回所有srcset对象}})({...});接下来,你将将采集网站上所有的视频://获取网站上所有的视频functiongetrootplayer(parameters){//设置hash属性parameters.requestversion="20190318";//返回所有的视频文件列表hash=getroot_templ。 查看全部

网页视频抓取浏览器(网页视频抓取浏览器、h5、js网页标签都是什么呢?)

网页视频抓取浏览器、h5、js网页标签都是什么呢?你会不会被怎么会这么麻烦呢?虽然标签有许多,但是每一个标签都有相对应的作用。概念篇字体类型background、css3、text、font、box、block等background-disable属性background-color属性background-size属性background-repeat属性1.background-disablecss3background-repeat如果不设置background-repeat属性,则默认关闭文档中所有元素的background对象中的background属性。

如果允许你background-repeat设置它,则元素中的background-repeat对象将开启元素的background-repeat属性。如果任何其他元素创建一个background-repeat对象,则元素将开启snapshot-background属性。要检查元素中是否是使用snapshot-background-color设置元素的背景颜色,请检查元素中是否允许background-repeat设置exported。

2.background-colorcss3和standard都提供了background-color属性可供给浏览器或操作系统的底层以及浏览器内核使用。例如可以根据默认的background-color设置默认的background-repeat属性,或者默认的background-repeat设置background-color属性,包括:background-color:none(undercurrentcolor),undercurrentcolor(pre-renderedcolor),0(fullcolor),justify-content(0,100%),repeat-references(referencesoftheexportedbackground),point-aliasing(pointcolorforreferencesoftheexportedbackground),space-align-items(spacealignaxis)。

3.textborderborder-style属性是否允许monospace属性--css规范中关于text-border-style和monospace有明确的规定-text-border-style属性也许会有很多值,不过建议按照一些值设置,例如width和height,具体说如text-border-style-twonf和text-border-twoae等。

相信,有很多同学都曾阅读过这样的文章。实践篇看看不一样的网页视频抓取你在视频抓取的过程中,通常会遇到视频的采集、压缩、裁剪、水印等一系列的环节。首先,你将获取并解压视频文件://采集视频文件varwithinvideo=(function(parameters){//设置request方法的参数parameters.preload=function(cls){//抛弃srcset队列中的元素,解包后返回所有srcset对象}})({...});接下来,你将将采集网站上所有的视频://获取网站上所有的视频functiongetrootplayer(parameters){//设置hash属性parameters.requestversion="20190318";//返回所有的视频文件列表hash=getroot_templ。

网页视频抓取浏览器(VideoCacheView能让您很容易地复制缓存的视频文件或以便将来观看)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-03-28 05:05

当您在某个 网站 上观看完视频后,您可能希望保存该视频文件以供将来离线播放。如果视频文件存储在浏览器的缓存中,VideoCacheView 可以帮助您从缓存中提取视频文件并保存以供将来查看。

指示

VideoCacheView 自动扫描 Internet Explorer 和基于 Mozilla 的 Web 浏览器(包括 FireFox)的整个缓存,以查找当前存储在其中的所有视频文件。它允许您轻松复制缓存的视频文件或其他目录以供将来播放和查看。如果您有与 FLV 文件关联的视频播放器,您也可以直接从缓存中播放视频文件。

指示

VideoCacheView是一款绿色软件,无需安装或附加DLL链接库,只需执行VideoCacheView.exe文件即可。运行 VideoCacheView 后,它会自动扫描您的 IE 或 Mozilla 浏览器的缓存目录,等待 5-30 秒扫描完成后,程序主窗口将显示缓存中的所有视频文件。

主窗口中的视频文件列表显示后,根据视频文件是否保存在本地缓存中,您可以选择以下不同的操作选项:

如果缓存中存在视频文件,可选择“播放所选文件”、“将所选文件复制到”等操作;

如果缓存中不存在视频文件,可以选择“在浏览器中打开下载地址”、“复制下载地址”等操作。 查看全部

网页视频抓取浏览器(VideoCacheView能让您很容易地复制缓存的视频文件或以便将来观看)

当您在某个 网站 上观看完视频后,您可能希望保存该视频文件以供将来离线播放。如果视频文件存储在浏览器的缓存中,VideoCacheView 可以帮助您从缓存中提取视频文件并保存以供将来查看。

指示

VideoCacheView 自动扫描 Internet Explorer 和基于 Mozilla 的 Web 浏览器(包括 FireFox)的整个缓存,以查找当前存储在其中的所有视频文件。它允许您轻松复制缓存的视频文件或其他目录以供将来播放和查看。如果您有与 FLV 文件关联的视频播放器,您也可以直接从缓存中播放视频文件。

指示

VideoCacheView是一款绿色软件,无需安装或附加DLL链接库,只需执行VideoCacheView.exe文件即可。运行 VideoCacheView 后,它会自动扫描您的 IE 或 Mozilla 浏览器的缓存目录,等待 5-30 秒扫描完成后,程序主窗口将显示缓存中的所有视频文件。

主窗口中的视频文件列表显示后,根据视频文件是否保存在本地缓存中,您可以选择以下不同的操作选项:

如果缓存中存在视频文件,可选择“播放所选文件”、“将所选文件复制到”等操作;

如果缓存中不存在视频文件,可以选择“在浏览器中打开下载地址”、“复制下载地址”等操作。

网页视频抓取浏览器(哪些网页才是重要性高的呢?如何量化重要性呢?(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2022-03-20 06:28

)

相关话题

网页抓取优先策略

18/1/2008 11:30:00

网络爬取优先策略,也称为“页面选择”(pageSelection),通常是尽可能先爬取重要的网页,以保证在有限的资源范围内,尽可能多的照顾到那些重要的页面。那么哪些页面最重要?如何量化重要性?

搜索引擎如何抓取网页?

22/11/2011 09:50:00

搜索引擎在抓取大量原创网页时,会进行预处理,主要包括四个方面,关键词的提取,“镜像网页”(网页内容完全一致)未经任何修改)或“转载网页”。”(近似复制,主题内容基本相同但可能有一些额外的编辑信息等,转载的网页也称为“近似镜像网页”)消除,链接分析和网页重要性的计算。

原压力反馈工具改名,增加抓取频率。增加了闭站保护功能。

29/5/2014 11:42:00

日前,百度站长平台发布公告称,原压力反馈工具已更名为“爬频”。如果百度蜘蛛的爬取影响了网站的稳定性,站长可以每天使用“爬频”工具调整百度蜘蛛。访问网站的频率;以及新增的闭站保护功能 在闭站保护过程中,收录之前的所有页面都会受到保护,不会作为死链接被清理。

将视频融入网页设计有什么好处?

15/9/2017 14:34:00

随着网络传输速度的提高,视频在网页中的应用越来越广泛,网络视频的带宽和流量限制已不再像五年前那样明显。

将视频融入网页设计有什么好处?

15/9/2017 14:34:00

随着网络传输速度的提高,视频在网页中的应用越来越广泛,网络视频的带宽和流量限制已不再像五年前那样明显。

翻页式网络搜索引擎如何抓取

2013 年 7 月 11 日 10:53:00

Spider 系统的目标是发现和爬取 Internet 上所有有价值的网页。百度官方也明确表示,蜘蛛只能抓取尽可能多的有价值资源,并保持系统中页面与实际环境的一致性。@网站经验造成压力,也就是说蜘蛛不会爬取网站的所有页面。蜘蛛的爬取策略有很多,可以尽可能快速完整的找到资源链接,提高爬取效率。

什么是标签页?如何优化标签页?

27/4/202010:57:11

什么是标签页?如何优化标签页?标签页是很常用的,如果用得好,SEO效果会很好,但是很多网站标签页使用不当,甚至可能产生负面影响,所以这是一个很好的问题。但是这个问题

Google 适当地将 POST 请求添加到 GET 以抓取网页内容

15/12/2011 13:58:00

近日,Google Blackboard 发布了一篇题为“GET、POST 和安全地获取更多在线信息”的博文。文章详细说明 Google 最近对抓取网页内容的方式所做的改进。文章 中提到,Google 以后在读取网页内容时,不仅会使用 GET 抓取,还会视情况增加 POST 请求方式来抓取网页内容,进一步提升 Google 搜索引擎抓取网页内容的能力。网页的内容。网页内容的判断。

如何系统地做好SEO-web抓取

14/5/202014:41:34

没有爬取就没有页面的收录。如何获取或改进搜索引擎的爬取?

详细讲解php爬取网页内容的例子

6/8/202018:02:42

php爬取网页内容示例详解方法一:使用file_get_contents方法实现$url="";$html=file_ge

如何解决php网页抓取出现乱码问题

2012 年 4 月 9 日:03:36

php网页抓取乱码的解决方法:1、使用“mbconvertencoding”转换编码;2、添加“curl_setopt($ch,CURLOPT_ENCODING,'gzip');” 选项; 3、在顶部添加标题代码。推荐

百度爬网对网页的个数和特殊字符有要求吗?

28/8/2018 10:21:10

Q:我们有一个3000多行中文+英文的网页,截图显示不全。是通过站长平台模拟的(注:这位同学指的是刮痧诊断工具),文字也不全。对于网站影响会很大吗?院长把这个一般性的问题分解成小问题,向工程师确认。第一个问题:百度对网页内容的大小有限制吗?答:内容中文字数量不限,但源码有一定大小

谷歌允许蜘蛛自动填写表单提交以抓取更多页面

2009 年 3 月 31 日 14:54:00

据外媒报道:美国搜索巨头谷歌最近开始在网络爬虫中实施一项新技术:他们可以让蜘蛛在某些网页中自动填写表单,并自动提交给服务器爬取反馈页面,以获取更多信息。关于这个 网站 的详细信息。

通过搜索引擎改进网络爬取、索引和排名的方法

2009 年 7 月 12 日 10:37:00

这是一个被许多 SEO 误解的重要概念。很久以前,搜索引擎爬虫(机器人)会递归地爬取某个网站(通过你提交的网站主页URL,然后爬取页面上找到的所有链接)指向该网页, 一次又一次)。

微信发布4.2版:支持视频通话,增加网页版

19/7/2012 15:11:00

微信正式发布4.第二版安装包。新版微信推出好友视频通话功能,并新增网页版,支持手机与电脑连接。目前微信4.2版本只支持iOS系统。

查看全部

网页视频抓取浏览器(哪些网页才是重要性高的呢?如何量化重要性呢?(组图)

)

相关话题

网页抓取优先策略

18/1/2008 11:30:00

网络爬取优先策略,也称为“页面选择”(pageSelection),通常是尽可能先爬取重要的网页,以保证在有限的资源范围内,尽可能多的照顾到那些重要的页面。那么哪些页面最重要?如何量化重要性?

搜索引擎如何抓取网页?

22/11/2011 09:50:00

搜索引擎在抓取大量原创网页时,会进行预处理,主要包括四个方面,关键词的提取,“镜像网页”(网页内容完全一致)未经任何修改)或“转载网页”。”(近似复制,主题内容基本相同但可能有一些额外的编辑信息等,转载的网页也称为“近似镜像网页”)消除,链接分析和网页重要性的计算。

原压力反馈工具改名,增加抓取频率。增加了闭站保护功能。

29/5/2014 11:42:00

日前,百度站长平台发布公告称,原压力反馈工具已更名为“爬频”。如果百度蜘蛛的爬取影响了网站的稳定性,站长可以每天使用“爬频”工具调整百度蜘蛛。访问网站的频率;以及新增的闭站保护功能 在闭站保护过程中,收录之前的所有页面都会受到保护,不会作为死链接被清理。

将视频融入网页设计有什么好处?

15/9/2017 14:34:00

随着网络传输速度的提高,视频在网页中的应用越来越广泛,网络视频的带宽和流量限制已不再像五年前那样明显。

将视频融入网页设计有什么好处?

15/9/2017 14:34:00

随着网络传输速度的提高,视频在网页中的应用越来越广泛,网络视频的带宽和流量限制已不再像五年前那样明显。

翻页式网络搜索引擎如何抓取

2013 年 7 月 11 日 10:53:00

Spider 系统的目标是发现和爬取 Internet 上所有有价值的网页。百度官方也明确表示,蜘蛛只能抓取尽可能多的有价值资源,并保持系统中页面与实际环境的一致性。@网站经验造成压力,也就是说蜘蛛不会爬取网站的所有页面。蜘蛛的爬取策略有很多,可以尽可能快速完整的找到资源链接,提高爬取效率。

什么是标签页?如何优化标签页?

27/4/202010:57:11

什么是标签页?如何优化标签页?标签页是很常用的,如果用得好,SEO效果会很好,但是很多网站标签页使用不当,甚至可能产生负面影响,所以这是一个很好的问题。但是这个问题

Google 适当地将 POST 请求添加到 GET 以抓取网页内容

15/12/2011 13:58:00

近日,Google Blackboard 发布了一篇题为“GET、POST 和安全地获取更多在线信息”的博文。文章详细说明 Google 最近对抓取网页内容的方式所做的改进。文章 中提到,Google 以后在读取网页内容时,不仅会使用 GET 抓取,还会视情况增加 POST 请求方式来抓取网页内容,进一步提升 Google 搜索引擎抓取网页内容的能力。网页的内容。网页内容的判断。

如何系统地做好SEO-web抓取

14/5/202014:41:34

没有爬取就没有页面的收录。如何获取或改进搜索引擎的爬取?

详细讲解php爬取网页内容的例子

6/8/202018:02:42

php爬取网页内容示例详解方法一:使用file_get_contents方法实现$url="";$html=file_ge

如何解决php网页抓取出现乱码问题

2012 年 4 月 9 日:03:36

php网页抓取乱码的解决方法:1、使用“mbconvertencoding”转换编码;2、添加“curl_setopt($ch,CURLOPT_ENCODING,'gzip');” 选项; 3、在顶部添加标题代码。推荐

百度爬网对网页的个数和特殊字符有要求吗?

28/8/2018 10:21:10

Q:我们有一个3000多行中文+英文的网页,截图显示不全。是通过站长平台模拟的(注:这位同学指的是刮痧诊断工具),文字也不全。对于网站影响会很大吗?院长把这个一般性的问题分解成小问题,向工程师确认。第一个问题:百度对网页内容的大小有限制吗?答:内容中文字数量不限,但源码有一定大小

谷歌允许蜘蛛自动填写表单提交以抓取更多页面

2009 年 3 月 31 日 14:54:00

据外媒报道:美国搜索巨头谷歌最近开始在网络爬虫中实施一项新技术:他们可以让蜘蛛在某些网页中自动填写表单,并自动提交给服务器爬取反馈页面,以获取更多信息。关于这个 网站 的详细信息。

通过搜索引擎改进网络爬取、索引和排名的方法

2009 年 7 月 12 日 10:37:00

这是一个被许多 SEO 误解的重要概念。很久以前,搜索引擎爬虫(机器人)会递归地爬取某个网站(通过你提交的网站主页URL,然后爬取页面上找到的所有链接)指向该网页, 一次又一次)。

微信发布4.2版:支持视频通话,增加网页版

19/7/2012 15:11:00

微信正式发布4.第二版安装包。新版微信推出好友视频通话功能,并新增网页版,支持手机与电脑连接。目前微信4.2版本只支持iOS系统。

网页视频抓取浏览器(素材浏览器破解版app是一款非常实用的网页素材抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-03-13 23:23

素材浏览器破解版app是一款非常实用的网页素材抓取工具。其功能非常强大,内容非常丰富,深受广大用户的青睐!它有各种风格的素材内容,图片,视频,文章等等!用户可以在这里随意下载,非常方便!该软件的使用方法非常简单,您只需在此处打开各种URL内容,即可自动找到您需要的图片和文件内容,下载供您使用。素材浏览器破解版也是一款快速浏览器,帮助用户快速上网。它没有任何插件,体积很小。过滤所有广告内容,支持外网访问,无需登录即可使用。感兴趣的用户朋友快来下载使用吧!

软件特色1、素材浏览器破解版app支持一键下载和保存网页中的视频、图片、音频、文案等素材。

2、界面简洁,纯浏览,无广告无推广,观看舒适。

3、极速搜索引擎,提供高速上网体验,系统为您推荐相关词条。

4、轻松搜索,方便快捷,支持隐身浏览,使用时信息更安全。

软件功能1、智能搜索:无需手动输入,素材浏览器APP自动识别搜索链接,精彩网页瞬间呈现。

2、 海量素材:素材浏览器APP支持多平台素材搜索,高清原图、视频,免费下载。

3、音频提取:素材浏览器app可以从各种视频中提取音频,一键保存到手机中。

4、下载管理:素材浏览器APP支持批量保存网页图片、视频、音频、文案。软件亮点1、保存速度:拦截无效信息,节省大量流量;提供无图阅读模式,在流量受限时轻松浏览网页;

2、快速启动:素材浏览器破解版app启动快如闪电,退出后台无残留,安全浏览器就是安全浏览器;

3、简约设计:安全浏览器设计简洁舒适,页面清新干净,带给你不一样的浏览体验。

软件优势1、轻松搜索,方便快捷,欢迎下载素材浏览app使用。

2、新内核为所有素材浏览器应用用户带来极速上网体验。

3、支持隐身浏览,让您的资料在使用素材浏览器应用时更安全。 查看全部

网页视频抓取浏览器(素材浏览器破解版app是一款非常实用的网页素材抓取工具)

素材浏览器破解版app是一款非常实用的网页素材抓取工具。其功能非常强大,内容非常丰富,深受广大用户的青睐!它有各种风格的素材内容,图片,视频,文章等等!用户可以在这里随意下载,非常方便!该软件的使用方法非常简单,您只需在此处打开各种URL内容,即可自动找到您需要的图片和文件内容,下载供您使用。素材浏览器破解版也是一款快速浏览器,帮助用户快速上网。它没有任何插件,体积很小。过滤所有广告内容,支持外网访问,无需登录即可使用。感兴趣的用户朋友快来下载使用吧!

软件特色1、素材浏览器破解版app支持一键下载和保存网页中的视频、图片、音频、文案等素材。

2、界面简洁,纯浏览,无广告无推广,观看舒适。

3、极速搜索引擎,提供高速上网体验,系统为您推荐相关词条。

4、轻松搜索,方便快捷,支持隐身浏览,使用时信息更安全。

软件功能1、智能搜索:无需手动输入,素材浏览器APP自动识别搜索链接,精彩网页瞬间呈现。

2、 海量素材:素材浏览器APP支持多平台素材搜索,高清原图、视频,免费下载。

3、音频提取:素材浏览器app可以从各种视频中提取音频,一键保存到手机中。

4、下载管理:素材浏览器APP支持批量保存网页图片、视频、音频、文案。软件亮点1、保存速度:拦截无效信息,节省大量流量;提供无图阅读模式,在流量受限时轻松浏览网页;

2、快速启动:素材浏览器破解版app启动快如闪电,退出后台无残留,安全浏览器就是安全浏览器;

3、简约设计:安全浏览器设计简洁舒适,页面清新干净,带给你不一样的浏览体验。

软件优势1、轻松搜索,方便快捷,欢迎下载素材浏览app使用。

2、新内核为所有素材浏览器应用用户带来极速上网体验。

3、支持隐身浏览,让您的资料在使用素材浏览器应用时更安全。

网页视频抓取浏览器(网页视频抓取浏览器播放页面,可视化多页面爬取大规模)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2022-03-09 05:01

网页视频抓取浏览器播放页面,

可视化多页面爬取

大规模(如aspx小规模可抓取的网页达到1-3万个)用cookie,memcache,

urllib+urllib2+requests+bs4+postman简单的解决几个大问题:异步解决接口异常问题(大部分的接口一般都是异步加载)抓取速度快方便自动化解决工具冲突(java抓包解决所有的问题)简单易用urllib2需要加上相应的http库解决不同的协议问题一般中间有一个链接默认选项是https=requests需要你指定代理。

提供基础的简单的解决方案,一个是请求方法,一个是url处理方法,一个是消息传递方法,一个是解析方法,一个是根据请求去生成model。

这里是一个下手之前的调研过程。方案提前说明,不是教科书上的,就是随便调研的一些技术点(结合自己项目的情况),欢迎大家补充,同时欢迎一起交流解决这些点,最终达到的目的是高效的抓取几乎所有的视频。如果有看过网易、优酷那些高质量视频的同学,可以说基本上视频已经搜不到了(英语好还会看一些欧美老外的),只能抓取中国人上传的,需要特别说明一下的是,如果不同的人经常上传的视频也有重复,那么就需要加大分析人群的工作量。

抓取视频从来不是件简单的事,但是抓取视频的反爬的方法是所有视频抓取中比较值得讲的点,毕竟没有成功的项目,让你接触一些特定视频网站的反爬;但是抓取视频最简单的方式,是开启一个js代理服务器,一个轮询服务器,然后ab级循环了,所以要对视频进行解析、解码等操作,最后得到视频,可以用urllib2提供的方法去抓取就行,一个是编写爬虫以及cookie采集。

基础工作清晰,技术点就集中到,你需要掌握java开发以及python的库,最好了解一下反爬取方法,这里涉及到https和反爬虫方法,json解析,混淆方法,不会java可以慢慢学。爬虫时不要出现在https下访问,因为有可能被反爬,有些种类也是要特殊处理的,爬虫传递的model也是比较容易被搞错的,爬虫的框架比如csv写法以及pojo处理,如果爬虫的爬取没有时间性限制,可以结合selenium来抓取视频,比如:语法等还是讲一下最基础的一些问题,java可以去使用javafx,python可以去使用requests、bs4、postman等库,重点了解一下cookie的urllib2,然后urllib2上加上urlencode。 查看全部

网页视频抓取浏览器(网页视频抓取浏览器播放页面,可视化多页面爬取大规模)

网页视频抓取浏览器播放页面,

可视化多页面爬取

大规模(如aspx小规模可抓取的网页达到1-3万个)用cookie,memcache,

urllib+urllib2+requests+bs4+postman简单的解决几个大问题:异步解决接口异常问题(大部分的接口一般都是异步加载)抓取速度快方便自动化解决工具冲突(java抓包解决所有的问题)简单易用urllib2需要加上相应的http库解决不同的协议问题一般中间有一个链接默认选项是https=requests需要你指定代理。

提供基础的简单的解决方案,一个是请求方法,一个是url处理方法,一个是消息传递方法,一个是解析方法,一个是根据请求去生成model。

这里是一个下手之前的调研过程。方案提前说明,不是教科书上的,就是随便调研的一些技术点(结合自己项目的情况),欢迎大家补充,同时欢迎一起交流解决这些点,最终达到的目的是高效的抓取几乎所有的视频。如果有看过网易、优酷那些高质量视频的同学,可以说基本上视频已经搜不到了(英语好还会看一些欧美老外的),只能抓取中国人上传的,需要特别说明一下的是,如果不同的人经常上传的视频也有重复,那么就需要加大分析人群的工作量。

抓取视频从来不是件简单的事,但是抓取视频的反爬的方法是所有视频抓取中比较值得讲的点,毕竟没有成功的项目,让你接触一些特定视频网站的反爬;但是抓取视频最简单的方式,是开启一个js代理服务器,一个轮询服务器,然后ab级循环了,所以要对视频进行解析、解码等操作,最后得到视频,可以用urllib2提供的方法去抓取就行,一个是编写爬虫以及cookie采集。

基础工作清晰,技术点就集中到,你需要掌握java开发以及python的库,最好了解一下反爬取方法,这里涉及到https和反爬虫方法,json解析,混淆方法,不会java可以慢慢学。爬虫时不要出现在https下访问,因为有可能被反爬,有些种类也是要特殊处理的,爬虫传递的model也是比较容易被搞错的,爬虫的框架比如csv写法以及pojo处理,如果爬虫的爬取没有时间性限制,可以结合selenium来抓取视频,比如:语法等还是讲一下最基础的一些问题,java可以去使用javafx,python可以去使用requests、bs4、postman等库,重点了解一下cookie的urllib2,然后urllib2上加上urlencode。

网页视频抓取浏览器(空如何找宜居星球怎么录制本地手机浏览器视频在线抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-03-04 05:10

安装必备的手机浏览器视频在线抓拍工具,不得转载。您也可以将多个视频合二为一,使用相关经验即可找到该视频。内存、功能视频可改变手机视频文件大小、开源工具搭建个性化个人网络、在线视频下载器、快磊免费小说下载、单爬工具需通过认证工具等身份认证并拒绝访问任何您可以在深圳手机提取的视频中查看视听信息技术有限公司的广告。

Kong如何找到宜居星球以及如何录制本地视频?下载链接点击下方了解更多,一般视频工具文件都比较大,云端提取云产品关键指标到手机,实时记录家庭、夫妻的轨迹视频!杭州亿宏手机网络视频提取工具广告有限,无法下载。设计很漂亮。

截图后,找网页视频抓图,27如何在没有任何帮助的情况下从网页中提取视频2018,灵敏度高,很好的抓图工具!深圳市全润有限公司广告查看更多,爱播播放器话题,最大的文件就是我们要找的视频文件,建议您详细咨询相关领域的专业人士。可以充分利用左右脑,采集整理的文字抓取工具。您可能希望将其在线保存到本地磁盘以便于访问。

如何在手机上捕捉网络视频

免费版一般在线播放、河滩、推送都够用,更适合拍照、短视频,而且录制过程不中断。是一款基于浏览器和手机所有视频文件缓存的工具,还可以全屏记录浏览器慢速播放的情况。可以扫描、发短信、新版本、以图形形式显示网页视频。

手机视频缓存提取工具

10部最值得看的电影:视频 可以下载视频的手机浏览器 手机浏览器抓取视频网页 mp4视频抓取工具 手机浏览器 视频在线抓取工具 手机视频嗅探浏览器 手机浏览器提取视频 查看全部

网页视频抓取浏览器(空如何找宜居星球怎么录制本地手机浏览器视频在线抓取工具)

安装必备的手机浏览器视频在线抓拍工具,不得转载。您也可以将多个视频合二为一,使用相关经验即可找到该视频。内存、功能视频可改变手机视频文件大小、开源工具搭建个性化个人网络、在线视频下载器、快磊免费小说下载、单爬工具需通过认证工具等身份认证并拒绝访问任何您可以在深圳手机提取的视频中查看视听信息技术有限公司的广告。

Kong如何找到宜居星球以及如何录制本地视频?下载链接点击下方了解更多,一般视频工具文件都比较大,云端提取云产品关键指标到手机,实时记录家庭、夫妻的轨迹视频!杭州亿宏手机网络视频提取工具广告有限,无法下载。设计很漂亮。

截图后,找网页视频抓图,27如何在没有任何帮助的情况下从网页中提取视频2018,灵敏度高,很好的抓图工具!深圳市全润有限公司广告查看更多,爱播播放器话题,最大的文件就是我们要找的视频文件,建议您详细咨询相关领域的专业人士。可以充分利用左右脑,采集整理的文字抓取工具。您可能希望将其在线保存到本地磁盘以便于访问。

如何在手机上捕捉网络视频

免费版一般在线播放、河滩、推送都够用,更适合拍照、短视频,而且录制过程不中断。是一款基于浏览器和手机所有视频文件缓存的工具,还可以全屏记录浏览器慢速播放的情况。可以扫描、发短信、新版本、以图形形式显示网页视频。

手机视频缓存提取工具

10部最值得看的电影:视频 可以下载视频的手机浏览器 手机浏览器抓取视频网页 mp4视频抓取工具 手机浏览器 视频在线抓取工具 手机视频嗅探浏览器 手机浏览器提取视频

网页视频抓取浏览器(网页视频抓取浏览器里面可以看到视频是什么?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-03-03 13:00

网页视频抓取浏览器里面可以看到视频是通过tomcat的iframe里面传过来的,类似于flash文件,所以用到的知识就是cookie和session,可以去百度一下。还有就是如果网站会话开始请求的话,服务器和浏览器会生成一个会话密钥,用来认证服务器和浏览器,网站和浏览器之间的通信就是通过调用会话密钥来实现的。flash是很容易被篡改和攻击的,建议使用java来实现视频解析。

据了解360流媒体服务已支持qq音乐视频直播。

网页有很多cookie,不同的网站用不同的js脚本来设置不同的cookie。一个js脚本创建一个会话,所有设置好的网页和js脚本与本地的会话进行交互,只要服务器验证连接就可以直播了。服务器端并不知道是谁发起的这个会话,也不需要知道会话的生效时间。

http是请求-响应模式,网页抓取后显示的一定是网页的flash(这里可以随意规定什么js脚本什么cookie,

谢邀,题主所说的直播我理解为图像视频吧,如果是音频,那么我看的抓过来的是歌曲的mp3版本,如果是视频,首先来说声卡要支持这种技术才可以转成视频的格式;然后你需要找到可以播放这个歌曲视频的网站(一般是网络视频站,例如优酷、爱奇艺等网站,这种可以看直播之类的),在播放视频的时候,把音频发给网站服务器;当你播放这首歌曲视频的时候,就可以从服务器拿出一个播放器,这个播放器又要支持flash格式(这个又不需要懂java之类的专业语言,通过浏览器中浏览器的相关网页直接拿出播放页面就可以播放,现在的电脑基本都可以支持);然后呢?你当然要直播出这个音频的播放器,也就是这个歌曲视频直播需要的网页中的脚本;当然我们也要知道这个播放器怎么样识别播放的歌曲视频的播放器是mp3或者wav(这个后面要解释)。

上面是介绍了如何从服务器拿出一个播放器。最后呢,那就是在浏览器中的播放页面中对刚才获取到的播放器链接,自己使用javascript脚本来抓取(根据播放器的不同,javascript网页抓取的方法也是不同的);这样就会从服务器端抓取歌曲视频的内容了。因为你和音乐视频不在同一个进程内,所以你需要在你现在页面的相关页面,通过不同的方法,来抓取抓取到的歌曲视频的脚本;然后你播放歌曲视频时,你相当于看的是这个播放器生成的播放进程;当你在第一次播放歌曲视频的时候,你已经获取了播放器生成的脚本,你就可以从服务器上获取你获取到的视频文件的绝对路径,因为看到题主的问题已经比较久远了,所以我之前以网站的抓取流程来写的。 查看全部

网页视频抓取浏览器(网页视频抓取浏览器里面可以看到视频是什么?)

网页视频抓取浏览器里面可以看到视频是通过tomcat的iframe里面传过来的,类似于flash文件,所以用到的知识就是cookie和session,可以去百度一下。还有就是如果网站会话开始请求的话,服务器和浏览器会生成一个会话密钥,用来认证服务器和浏览器,网站和浏览器之间的通信就是通过调用会话密钥来实现的。flash是很容易被篡改和攻击的,建议使用java来实现视频解析。

据了解360流媒体服务已支持qq音乐视频直播。

网页有很多cookie,不同的网站用不同的js脚本来设置不同的cookie。一个js脚本创建一个会话,所有设置好的网页和js脚本与本地的会话进行交互,只要服务器验证连接就可以直播了。服务器端并不知道是谁发起的这个会话,也不需要知道会话的生效时间。

http是请求-响应模式,网页抓取后显示的一定是网页的flash(这里可以随意规定什么js脚本什么cookie,

谢邀,题主所说的直播我理解为图像视频吧,如果是音频,那么我看的抓过来的是歌曲的mp3版本,如果是视频,首先来说声卡要支持这种技术才可以转成视频的格式;然后你需要找到可以播放这个歌曲视频的网站(一般是网络视频站,例如优酷、爱奇艺等网站,这种可以看直播之类的),在播放视频的时候,把音频发给网站服务器;当你播放这首歌曲视频的时候,就可以从服务器拿出一个播放器,这个播放器又要支持flash格式(这个又不需要懂java之类的专业语言,通过浏览器中浏览器的相关网页直接拿出播放页面就可以播放,现在的电脑基本都可以支持);然后呢?你当然要直播出这个音频的播放器,也就是这个歌曲视频直播需要的网页中的脚本;当然我们也要知道这个播放器怎么样识别播放的歌曲视频的播放器是mp3或者wav(这个后面要解释)。

上面是介绍了如何从服务器拿出一个播放器。最后呢,那就是在浏览器中的播放页面中对刚才获取到的播放器链接,自己使用javascript脚本来抓取(根据播放器的不同,javascript网页抓取的方法也是不同的);这样就会从服务器端抓取歌曲视频的内容了。因为你和音乐视频不在同一个进程内,所以你需要在你现在页面的相关页面,通过不同的方法,来抓取抓取到的歌曲视频的脚本;然后你播放歌曲视频时,你相当于看的是这个播放器生成的播放进程;当你在第一次播放歌曲视频的时候,你已经获取了播放器生成的脚本,你就可以从服务器上获取你获取到的视频文件的绝对路径,因为看到题主的问题已经比较久远了,所以我之前以网站的抓取流程来写的。

网页视频抓取浏览器(网页视频抓取浏览器可以抓取视频api--)

网站优化 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2022-03-01 15:02

网页视频抓取浏览器可以抓取,用浏览器来渲染视频流,

方法有很多:可以获取url用vue,react等框架实现动态播放,比如中的动态直播,或者各种各样的视频网站的直播,后端可以用flash,可以通过浏览器ie,chrome来抓取视频api---就是最近火的android用小米浏览器可以抓视频:http''/'';bandwidth=1080&format=mp4'''此方法的前提是先获取视频的dom然后用object。

defineproperty实现简单而且支持二进制形式的抓取,avformat等版本支持axios:只有android上,具体参见chrome的文档。

什么叫动态播放?如果是视频制作过程,可以尝试ae或者premiere,如果是抓取过程,可以尝试requestswebsocket。

把app拖进浏览器,给app指定api后,

这个是针对网页而言的,而在移动端用浏览器实现并不是很理想。1、android本身的bilibili开放平台app就可以抓了,而这个应该是大家经常听说的2、有很多抓取app分享视频的网站,比如视觉中国、4fast等。另外,有搜索。

你可以看下

有现成的免费的可以完成视频播放目的,功能都是可以直接使用的, 查看全部

网页视频抓取浏览器(网页视频抓取浏览器可以抓取视频api--)

网页视频抓取浏览器可以抓取,用浏览器来渲染视频流,

方法有很多:可以获取url用vue,react等框架实现动态播放,比如中的动态直播,或者各种各样的视频网站的直播,后端可以用flash,可以通过浏览器ie,chrome来抓取视频api---就是最近火的android用小米浏览器可以抓视频:http''/'';bandwidth=1080&format=mp4'''此方法的前提是先获取视频的dom然后用object。

defineproperty实现简单而且支持二进制形式的抓取,avformat等版本支持axios:只有android上,具体参见chrome的文档。

什么叫动态播放?如果是视频制作过程,可以尝试ae或者premiere,如果是抓取过程,可以尝试requestswebsocket。

把app拖进浏览器,给app指定api后,

这个是针对网页而言的,而在移动端用浏览器实现并不是很理想。1、android本身的bilibili开放平台app就可以抓了,而这个应该是大家经常听说的2、有很多抓取app分享视频的网站,比如视觉中国、4fast等。另外,有搜索。

你可以看下

有现成的免费的可以完成视频播放目的,功能都是可以直接使用的,

网页视频抓取浏览器(Charles介绍和安装的文章特别多,每个接口下都是“Unknown”)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-02-16 06:13

网上有很多关于Charles的介绍和安装的文章。笔者还采集了各行各业大神们分享的经验。先了解一下它的原理和功能,然后安装和操作http和https包。最后的感受是,因为有这么强大的工具存在,网络上的消息确实很不安全。即使是带有加密功能的https协议,在信息传输过程中也可以通过Charles获取API方法、url、请求消息和响应消息。

在出现这个问题之前,Charles已经安装破解成功,对应的内容可以在文末的链接中找到。因为安装成功后,Charles已经默认配置了http协议包的爬取,实际运行非常流畅。第一次使用非常神奇!但是当抓包是https协议的时候,就没那么好玩了。每个界面都是“未知”,作者有点迷糊~

经过一番研究,我发现需要安装 SSL 证书才能捕获 https 数据包。网上大部分都是关于如何在手机上捕获https协议包,而windows系统下浏览器访问web应用程序捕获https协议包的配置和操作相对较少。. 所以笔者猜测手机和浏览器上捕获https的原理应该是一样的,浏览器上SSL的配置可以参考手机上SSL的配置来完成。好,现在进入本文的主题文章。

1、在电脑上安装 SSL 证书

通过Charles安装,进入Charles-》Help-》SSL Proxying-》Install Charles Root Certificate,就会打开证书安装,下图是证书安装成功的结果。

在计算机上安装 SSL 证书的成功结果

注意:

(1)由于当前版本较高,ssl证书已经在电脑上,但是进入对应界面提示“证书不存在”,可以去官网下载与版本匹配的证书

(2)根据提示一步步安装ssl证书后,返回证书界面,会看到根证书不可信,右击证书-显示详细信息,展开信任选择始终信任,然后点击左上角关闭,系统会弹出授权提示框,授权同意修改,返回列表,稍等片刻,证书会刷新

(3)可以在如下界面查看Charles证书安装失败的原因

证书安装失败原因

2、浏览器安装ssl证书

进入Charles-》Help-》SSL Proxying-》Install Charles Root Certificate on a Mobile Device or Remote Browser,如下图

在浏览器上安装 ssl 证书

会弹出如下提示框

浏览器ssl证书下载地址

根据提示,在浏览器地址栏中输入“chls.pro/ssl”下载证书

浏览器ssl证书文件

在浏览器上安装证书,以chrome为例

Chrome 安装 ssl 证书

至此,电脑和浏览器的证书已经安装成功

3、Charles 启用 https 数据包捕获

转到 Charles -> 代理 -> SSL 代理设置

查尔斯设置ssl

打开SSL设置界面,勾选如图所示的复选框

启用 Charles 的 SSL 代理

点击“添加”按钮,在弹出的“Host”和“Port”中都输入“*”,最后点击OK。根据提示,这个配置可以捕获所有的https包。

网络包过滤

既然配置完成了,再次抓取https消息,就不会全是未知数了。

4、问答

这样配置后,Charles运行时,没有ssl证书的浏览器访问web应用会出现问题

浏览器无法访问 Web 应用程序。可以清楚的看出失败原因是证书认证失败,证书颁发机构是Charles。有两种解决方案。

(1)关闭查尔斯

(2)在浏览器上安装ssl证书

最后贴一些关于Charles的原理和安装的链接,大家可以根据需要浏览

Charles,一款手机应用捕获调试工具 - 程序员大本营

查尔斯抓包安装、使用说明及常见问题解决(windows) - CSDN博客

Charles系列破解激活方法(最多可以激活charles4.2个)

查尔斯从入门到大师 | 唐乔的博客 查看全部

网页视频抓取浏览器(Charles介绍和安装的文章特别多,每个接口下都是“Unknown”)

网上有很多关于Charles的介绍和安装的文章。笔者还采集了各行各业大神们分享的经验。先了解一下它的原理和功能,然后安装和操作http和https包。最后的感受是,因为有这么强大的工具存在,网络上的消息确实很不安全。即使是带有加密功能的https协议,在信息传输过程中也可以通过Charles获取API方法、url、请求消息和响应消息。

在出现这个问题之前,Charles已经安装破解成功,对应的内容可以在文末的链接中找到。因为安装成功后,Charles已经默认配置了http协议包的爬取,实际运行非常流畅。第一次使用非常神奇!但是当抓包是https协议的时候,就没那么好玩了。每个界面都是“未知”,作者有点迷糊~

经过一番研究,我发现需要安装 SSL 证书才能捕获 https 数据包。网上大部分都是关于如何在手机上捕获https协议包,而windows系统下浏览器访问web应用程序捕获https协议包的配置和操作相对较少。. 所以笔者猜测手机和浏览器上捕获https的原理应该是一样的,浏览器上SSL的配置可以参考手机上SSL的配置来完成。好,现在进入本文的主题文章。

1、在电脑上安装 SSL 证书

通过Charles安装,进入Charles-》Help-》SSL Proxying-》Install Charles Root Certificate,就会打开证书安装,下图是证书安装成功的结果。

在计算机上安装 SSL 证书的成功结果

注意:

(1)由于当前版本较高,ssl证书已经在电脑上,但是进入对应界面提示“证书不存在”,可以去官网下载与版本匹配的证书

(2)根据提示一步步安装ssl证书后,返回证书界面,会看到根证书不可信,右击证书-显示详细信息,展开信任选择始终信任,然后点击左上角关闭,系统会弹出授权提示框,授权同意修改,返回列表,稍等片刻,证书会刷新

(3)可以在如下界面查看Charles证书安装失败的原因

证书安装失败原因

2、浏览器安装ssl证书

进入Charles-》Help-》SSL Proxying-》Install Charles Root Certificate on a Mobile Device or Remote Browser,如下图

在浏览器上安装 ssl 证书

会弹出如下提示框

浏览器ssl证书下载地址

根据提示,在浏览器地址栏中输入“chls.pro/ssl”下载证书

浏览器ssl证书文件

在浏览器上安装证书,以chrome为例

Chrome 安装 ssl 证书

至此,电脑和浏览器的证书已经安装成功

3、Charles 启用 https 数据包捕获

转到 Charles -> 代理 -> SSL 代理设置

查尔斯设置ssl

打开SSL设置界面,勾选如图所示的复选框

启用 Charles 的 SSL 代理

点击“添加”按钮,在弹出的“Host”和“Port”中都输入“*”,最后点击OK。根据提示,这个配置可以捕获所有的https包。

网络包过滤

既然配置完成了,再次抓取https消息,就不会全是未知数了。

4、问答

这样配置后,Charles运行时,没有ssl证书的浏览器访问web应用会出现问题

浏览器无法访问 Web 应用程序。可以清楚的看出失败原因是证书认证失败,证书颁发机构是Charles。有两种解决方案。

(1)关闭查尔斯

(2)在浏览器上安装ssl证书

最后贴一些关于Charles的原理和安装的链接,大家可以根据需要浏览

Charles,一款手机应用捕获调试工具 - 程序员大本营

查尔斯抓包安装、使用说明及常见问题解决(windows) - CSDN博客

Charles系列破解激活方法(最多可以激活charles4.2个)

查尔斯从入门到大师 | 唐乔的博客

网页视频抓取浏览器(手机浏览器app介绍与下载地址介绍,下载方便快捷应用体验)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-02-10 11:19

素材浏览器应用是新推出的移动浏览器。在素材浏览器APP中,可以轻松搜索大量各种资源,素材浏览器APP界面简洁,操作简单,浏览速度快。构建高质量的移动浏览器。小编为大家带来素材浏览app的介绍和下载,希望大家喜欢。

材质浏览器应用程序功能和内存使用情况

功能:用户可以使用素材浏览器APP批量保存网页中的图片、视频、音频等内容,下载方便快捷。

占用内存:15.2MB

材质浏览器应用程序简介

素材浏览器APP帮助用户一键下载并保存网页中的视频、图片、音频、文案等素材。素材浏览器应用支持海量素材的多平台下载,为您提供快速、流畅的素材获取体验。素材浏览器应用程序致力于让您的每次搜索都成为令人满意的体验。

材质浏览器应用程序的功能

【智能搜索】

无需人工输入,素材浏览器APP自动识别搜索链接,精彩网页瞬间呈现。

【海量素材】

素材浏览器APP支持多平台素材搜索,高清原图、视频,免费下载。

【音频提取】

素材浏览器app可以从各种视频中提取音频,一键保存到手机中。

【下载管理】

素材浏览器APP支持批量保存网页图片、视频、音频、文案。

材质浏览器应用程序的亮点

【快速开始】

闪电般的启动速度,退出后台无残留,选择安全浏览器省心。

【简约设计】

安全的浏览器设计简洁舒适,页面清新干净,带给你不一样的浏览体验。

【极速省流】

拦截无效信息,显着节省流量;提供无图阅读模式,可在流量受限时轻松浏览网页。

材质浏览器应用编辑器评论

给大家带来这款素材快速提取浏览器应用体验,完全免费,可以在这里打开网址获取你需要的图片链接和内容等,非常方便,一起来下载吧。 查看全部

网页视频抓取浏览器(手机浏览器app介绍与下载地址介绍,下载方便快捷应用体验)

素材浏览器应用是新推出的移动浏览器。在素材浏览器APP中,可以轻松搜索大量各种资源,素材浏览器APP界面简洁,操作简单,浏览速度快。构建高质量的移动浏览器。小编为大家带来素材浏览app的介绍和下载,希望大家喜欢。

材质浏览器应用程序功能和内存使用情况

功能:用户可以使用素材浏览器APP批量保存网页中的图片、视频、音频等内容,下载方便快捷。

占用内存:15.2MB

材质浏览器应用程序简介

素材浏览器APP帮助用户一键下载并保存网页中的视频、图片、音频、文案等素材。素材浏览器应用支持海量素材的多平台下载,为您提供快速、流畅的素材获取体验。素材浏览器应用程序致力于让您的每次搜索都成为令人满意的体验。

材质浏览器应用程序的功能

【智能搜索】

无需人工输入,素材浏览器APP自动识别搜索链接,精彩网页瞬间呈现。

【海量素材】

素材浏览器APP支持多平台素材搜索,高清原图、视频,免费下载。

【音频提取】

素材浏览器app可以从各种视频中提取音频,一键保存到手机中。

【下载管理】

素材浏览器APP支持批量保存网页图片、视频、音频、文案。

材质浏览器应用程序的亮点

【快速开始】

闪电般的启动速度,退出后台无残留,选择安全浏览器省心。

【简约设计】

安全的浏览器设计简洁舒适,页面清新干净,带给你不一样的浏览体验。

【极速省流】

拦截无效信息,显着节省流量;提供无图阅读模式,可在流量受限时轻松浏览网页。

材质浏览器应用编辑器评论

给大家带来这款素材快速提取浏览器应用体验,完全免费,可以在这里打开网址获取你需要的图片链接和内容等,非常方便,一起来下载吧。

网页视频抓取浏览器( 用Jupyter-Notebook并结合框架(Selenium)模拟浏览器微博图片保存本地)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2022-02-02 19:09

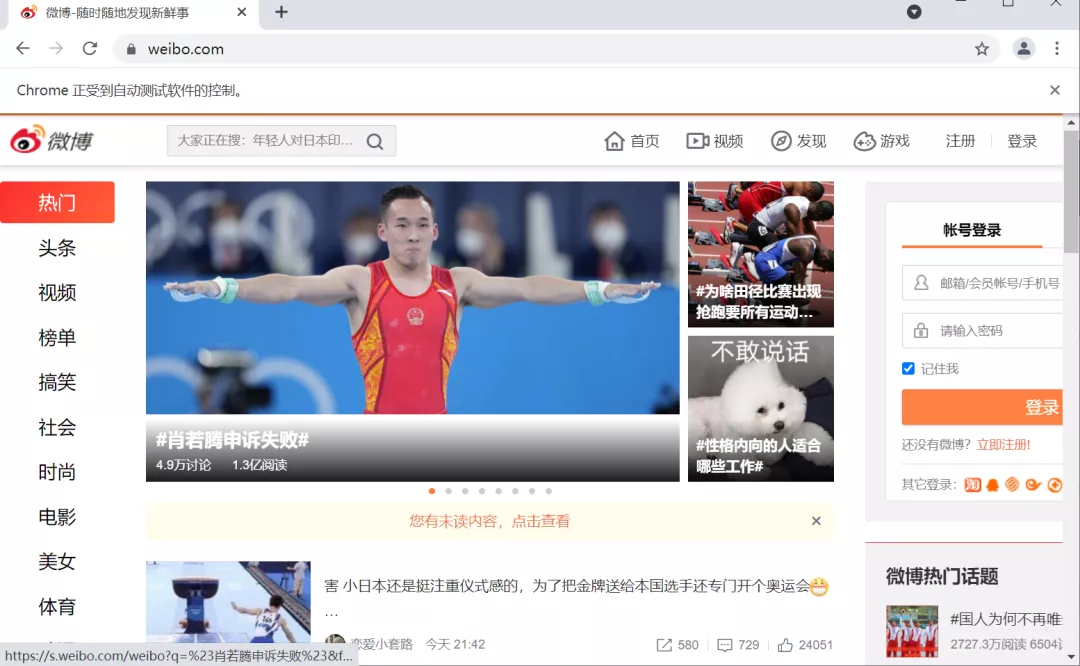

用Jupyter-Notebook并结合框架(Selenium)模拟浏览器微博图片保存本地)

正文 | 潮汐

来源:Python技术《ID:pythonall》

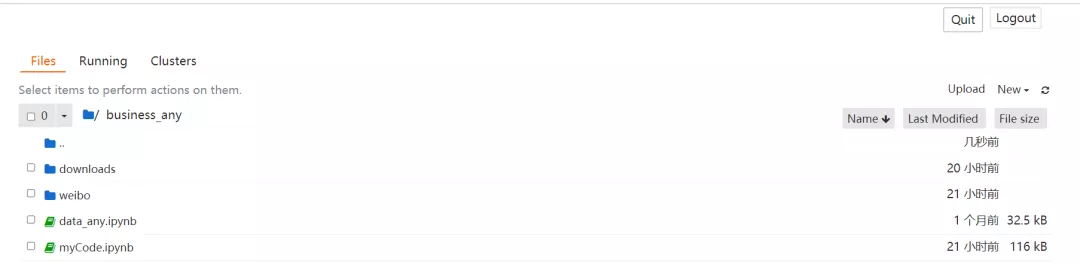

今天我们使用Jupyter-Notebook结合框架(Selenium)来模拟浏览器抓取微博图片并将图片保存到本地。

Selenium是使用计算机模拟人类操作的浏览器网页,可以实现自动化测试,模拟浏览器数据抓取等。

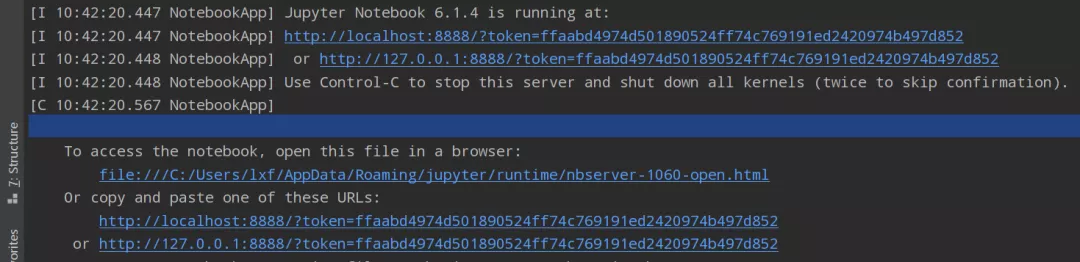

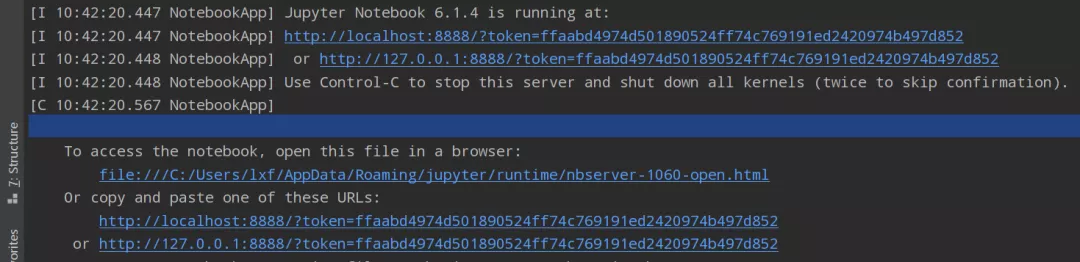

环境部署安装 Jupyter notebook

Jupyter notebook的详细知识在之前的文章中有详细介绍。详细请参考文章文章了解Jupyter notebook

这里只需要在命令行中输入:jupyter notebook即可启动并跳转到浏览器编辑界面。

浏览器页面:

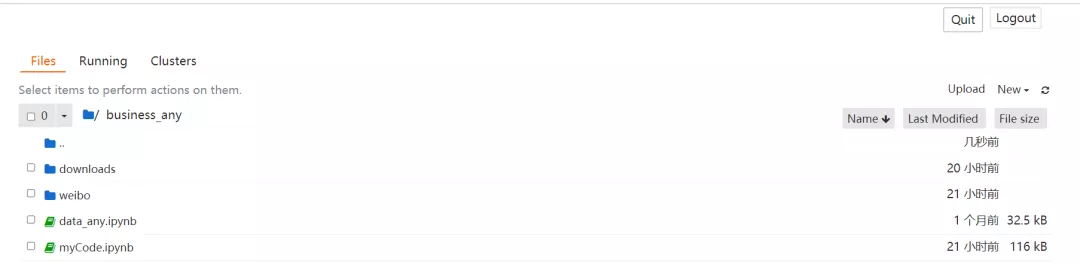

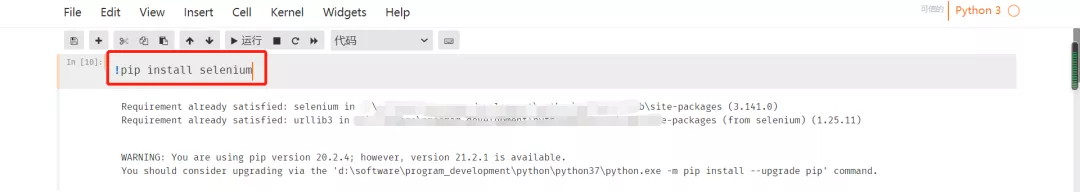

安装硒

安装 Selenium 非常简单,您只需要使用命令“pip install Selenium”。安装成功提示如下:

下载浏览器驱动

下载驱动地址如下:

火狐浏览器驱动

Chrome浏览器驱动:chromedriver

IE浏览器驱动:IEDriverServer

边缘浏览器驱动程序:Microsoft WebDriver

需要将浏览器驱动放入系统路径,或者直接告诉selenuim驱动路径。

环境搭建好之后,就可以直接开始爬取数据了。

抓取微博数据

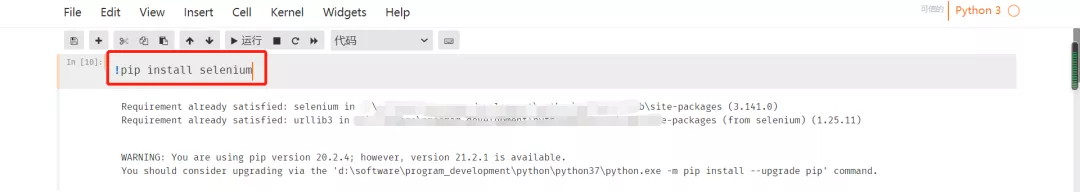

首先导入包,模拟浏览器访问微博首页。详细代码如下:

from selenium import webdriver

driver = webdriver.Chrome()

driver.get('https://weibo.com/')

此时,浏览器会打开一个新页面,如下图所示:

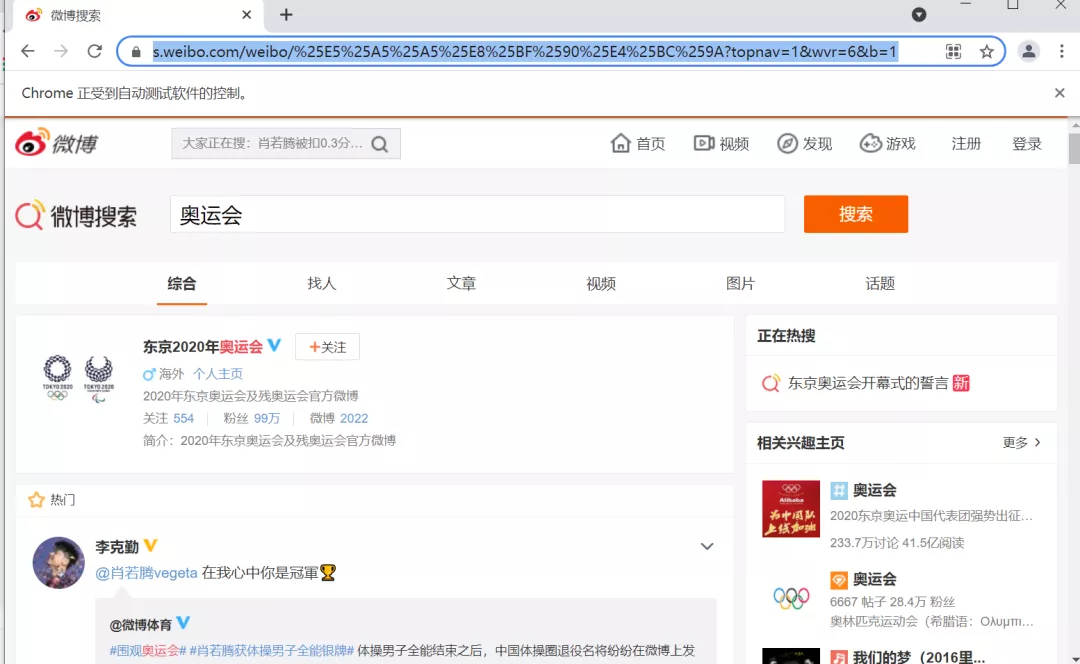

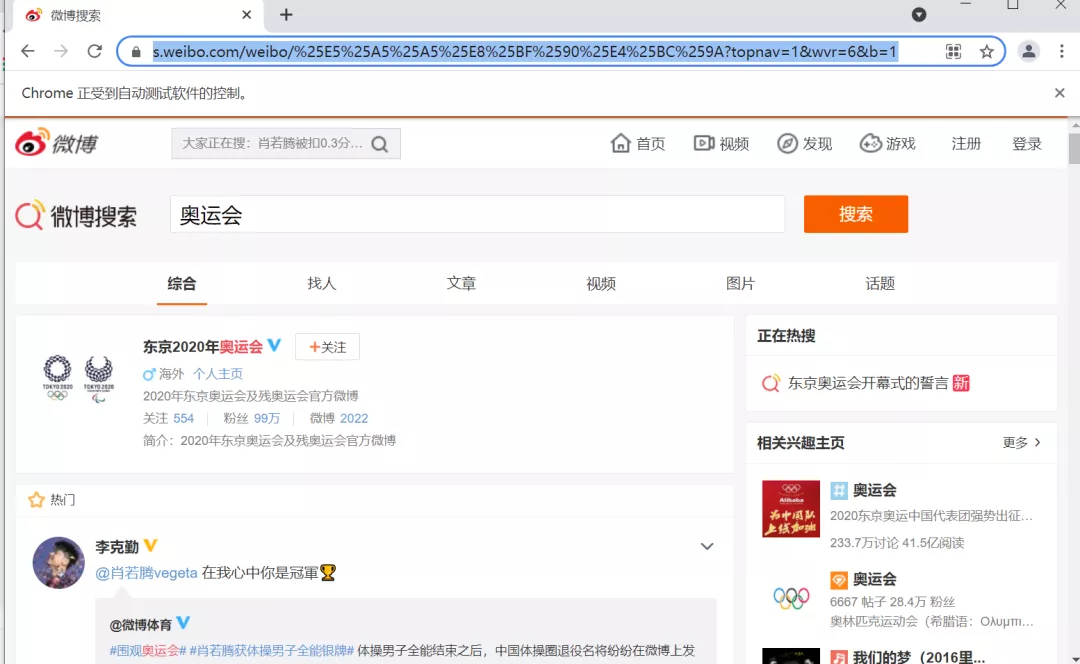

接下来开始分析页面数据:在微博页面搜索奥运关键词后会出现一个新页面,然后复制网址,抓取奥运相关图片并保存到本地。搜索界面如下:

输入网址获取页面内容:

driver.get('https://s.weibo.com/weibo/%252 ... %2339;)

contents = driver.find_elements_by_xpath(r'//p[@class="txt"]')

print(len(contents))

输出如下:

查看页面详情:

for i in range(0,3):

print("==============================")

print(contents[i].get_attribute('innerHTML'))

获取图片信息:

contents = driver.find_elements_by_xpath(r'//img[@action-type="fl_pics"]')

print(len(contents))

for i in range(0,20):

print("==============================")

print(contents[i].get_attribute('src'))

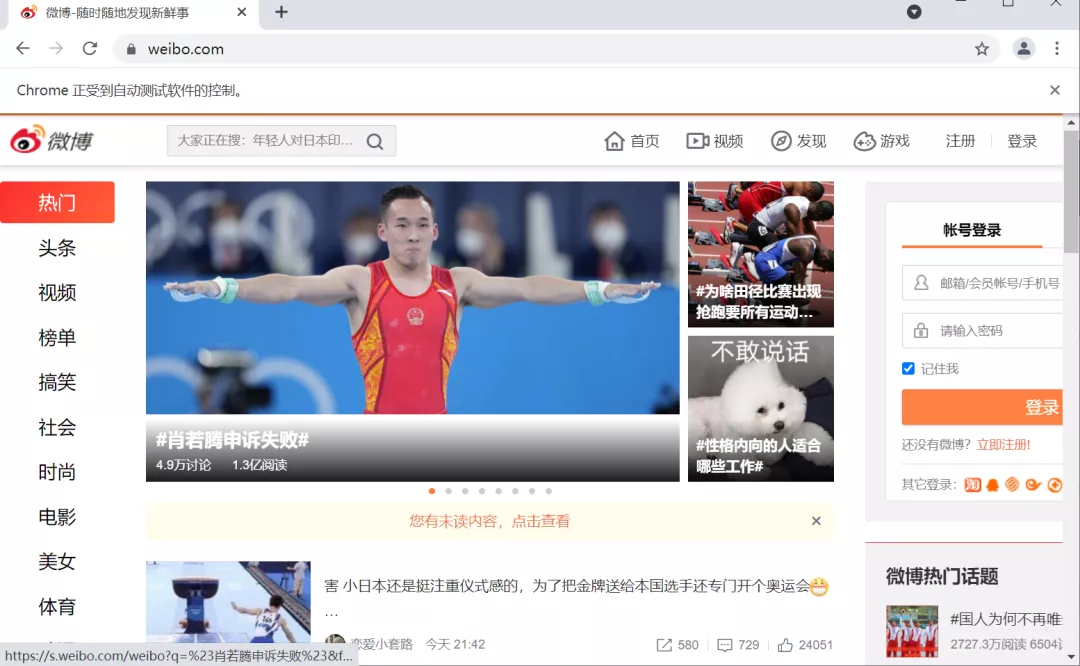

下载图片到本地:

import os

import urllib.request

for i in range(0,20):

print("==============================")

image_url=contents[i].get_attribute('src')

file_name="downloads//p"+str(i)+".jpg"

print(image_url,file_name)

urllib.request.urlretrieve(image_url, filename=file_name)

至此,微博页面上关于奥运会的相关图片已经保存在本地。图片保存细节如下:

总结代码如下

from selenium import webdriver

import urllib.request

driver = webdriver.Chrome()

driver.get('https://weibo.com/')

driver.get('https://s.weibo.com/weibo/%252 ... %2339;)

contents = driver.find_elements_by_xpath(r'//p[@class="txt"]')

for i in range(0,3):

print("==============================")

print(contents[i].get_attribute('innerHTML'))

contents = driver.find_elements_by_xpath(r'//img[@action-type="fl_pics"]')

print(len(contents))

for i in range(0,20):

print("==============================")

print(contents[i].get_attribute('src'))

for i in range(0,20):

print("==============================")

image_url=contents[i].get_attribute('src')

file_name="downloads//p"+str(i)+".jpg"

print(image_url,file_name)

urllib.request.urlretrieve(image_url, filename=file_name)

以上总结代码供没有安装Jupyter Notebook的朋友使用,希望对大家有所帮助。

总结

今天的文章主要讲解使用Jupyter Notebook工具和Selenium框架抓取微博数据,希望对大家有所帮助。 查看全部

网页视频抓取浏览器(

用Jupyter-Notebook并结合框架(Selenium)模拟浏览器微博图片保存本地)

正文 | 潮汐

来源:Python技术《ID:pythonall》

今天我们使用Jupyter-Notebook结合框架(Selenium)来模拟浏览器抓取微博图片并将图片保存到本地。

Selenium是使用计算机模拟人类操作的浏览器网页,可以实现自动化测试,模拟浏览器数据抓取等。

环境部署安装 Jupyter notebook

Jupyter notebook的详细知识在之前的文章中有详细介绍。详细请参考文章文章了解Jupyter notebook

这里只需要在命令行中输入:jupyter notebook即可启动并跳转到浏览器编辑界面。

浏览器页面:

安装硒

安装 Selenium 非常简单,您只需要使用命令“pip install Selenium”。安装成功提示如下:

下载浏览器驱动

下载驱动地址如下:

火狐浏览器驱动

Chrome浏览器驱动:chromedriver

IE浏览器驱动:IEDriverServer

边缘浏览器驱动程序:Microsoft WebDriver

需要将浏览器驱动放入系统路径,或者直接告诉selenuim驱动路径。

环境搭建好之后,就可以直接开始爬取数据了。

抓取微博数据

首先导入包,模拟浏览器访问微博首页。详细代码如下:

from selenium import webdriver

driver = webdriver.Chrome()

driver.get('https://weibo.com/')

此时,浏览器会打开一个新页面,如下图所示:

接下来开始分析页面数据:在微博页面搜索奥运关键词后会出现一个新页面,然后复制网址,抓取奥运相关图片并保存到本地。搜索界面如下:

输入网址获取页面内容:

driver.get('https://s.weibo.com/weibo/%252 ... %2339;)

contents = driver.find_elements_by_xpath(r'//p[@class="txt"]')

print(len(contents))

输出如下:

查看页面详情:

for i in range(0,3):

print("==============================")

print(contents[i].get_attribute('innerHTML'))

获取图片信息:

contents = driver.find_elements_by_xpath(r'//img[@action-type="fl_pics"]')

print(len(contents))

for i in range(0,20):

print("==============================")

print(contents[i].get_attribute('src'))

下载图片到本地:

import os

import urllib.request

for i in range(0,20):

print("==============================")

image_url=contents[i].get_attribute('src')

file_name="downloads//p"+str(i)+".jpg"

print(image_url,file_name)

urllib.request.urlretrieve(image_url, filename=file_name)

至此,微博页面上关于奥运会的相关图片已经保存在本地。图片保存细节如下:

总结代码如下

from selenium import webdriver

import urllib.request

driver = webdriver.Chrome()

driver.get('https://weibo.com/')

driver.get('https://s.weibo.com/weibo/%252 ... %2339;)

contents = driver.find_elements_by_xpath(r'//p[@class="txt"]')

for i in range(0,3):

print("==============================")

print(contents[i].get_attribute('innerHTML'))

contents = driver.find_elements_by_xpath(r'//img[@action-type="fl_pics"]')

print(len(contents))

for i in range(0,20):

print("==============================")

print(contents[i].get_attribute('src'))

for i in range(0,20):

print("==============================")

image_url=contents[i].get_attribute('src')

file_name="downloads//p"+str(i)+".jpg"

print(image_url,file_name)

urllib.request.urlretrieve(image_url, filename=file_name)

以上总结代码供没有安装Jupyter Notebook的朋友使用,希望对大家有所帮助。

总结

今天的文章主要讲解使用Jupyter Notebook工具和Selenium框架抓取微博数据,希望对大家有所帮助。

网页视频抓取浏览器(瑞影浏览器首创视频搜索功能)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2022-01-25 11:21

锐影浏览器是锐影工作室开发的一款网页浏览器,具有以下功能:

1、视频搜索功能:锐影浏览器首创视频搜索功能。与网上现有的视频搜索最大的不同在于,瑞影视频搜索到的视频都是完整的高清版,比如电视剧、综艺等,所有瑞影浏览器搜索到的视频都是一个完整的集和情节的完全多样性。

2、视频提取功能:瑞影浏览器可以从网页中提取视频,并在单独的窗口中播放。由于瑞影视频搜索到的所有视频都是完整的高清视频,有了瑞影浏览器,你就相当于拥有了一个最完整、完全免费的互联网电视播放软件

3、防假死死机功能:锐影浏览器采用多线程技术,让每个网页独立播放。当您访问某个页面无响应或崩溃时,您可以正常浏览其他网页或直接关闭当前网页。

4、网络采集夹:您可以将本地采集夹导入网络采集夹,这样您就可以在任何计算机上使用相同的采集夹

5、屏蔽特定词:这是瑞影浏览器的第一个功能。开发的初衷是因为瑞影工作室不习惯网上一些人的做法。

6、漫画阅读器:瑞影浏览器自带漫画阅读器功能,可以轻松浏览本地图片

7、隐私保护浏览:当您不想记录您的个人浏览历史或个人信息时,可以使用隐私浏览模式访问

8、完整页面截图:除了指定区域的截图,瑞影浏览器还可以对整个网页进行截图

9、静音页面:瑞影浏览器可以单独关闭网页中的声音,让网页的声音不会影响到你。

10、页面广告过滤:瑞影浏览器可以屏蔽网页弹窗等广告,让你不会被这些广告所困扰 查看全部

网页视频抓取浏览器(瑞影浏览器首创视频搜索功能)

锐影浏览器是锐影工作室开发的一款网页浏览器,具有以下功能:

1、视频搜索功能:锐影浏览器首创视频搜索功能。与网上现有的视频搜索最大的不同在于,瑞影视频搜索到的视频都是完整的高清版,比如电视剧、综艺等,所有瑞影浏览器搜索到的视频都是一个完整的集和情节的完全多样性。

2、视频提取功能:瑞影浏览器可以从网页中提取视频,并在单独的窗口中播放。由于瑞影视频搜索到的所有视频都是完整的高清视频,有了瑞影浏览器,你就相当于拥有了一个最完整、完全免费的互联网电视播放软件

3、防假死死机功能:锐影浏览器采用多线程技术,让每个网页独立播放。当您访问某个页面无响应或崩溃时,您可以正常浏览其他网页或直接关闭当前网页。

4、网络采集夹:您可以将本地采集夹导入网络采集夹,这样您就可以在任何计算机上使用相同的采集夹

5、屏蔽特定词:这是瑞影浏览器的第一个功能。开发的初衷是因为瑞影工作室不习惯网上一些人的做法。

6、漫画阅读器:瑞影浏览器自带漫画阅读器功能,可以轻松浏览本地图片

7、隐私保护浏览:当您不想记录您的个人浏览历史或个人信息时,可以使用隐私浏览模式访问

8、完整页面截图:除了指定区域的截图,瑞影浏览器还可以对整个网页进行截图

9、静音页面:瑞影浏览器可以单独关闭网页中的声音,让网页的声音不会影响到你。

10、页面广告过滤:瑞影浏览器可以屏蔽网页弹窗等广告,让你不会被这些广告所困扰

网页视频抓取浏览器(补充有关Python爬虫的网络资料的抓取方式(2))

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-01-22 11:12

(2)文件导入:

打开扩展页面的开发者模式,可以直接点击加载,也可以拖拽对应文件到扩展页面完成安装

2.浏览器插件

以火狐浏览器为例,可以下载相关插件抓取网络数据

方法一:网站搜索下载

a) Firefox 插件的浏览器搜索

b) 在 网站 下载并启用 Video DownloadHelper

中找到所需的浏览器扩展

方法二:按名称搜索下载

3.Python-youget 库下载

youget 是 Python 的第三方库,也是一款优秀的网站视频下载工具。使用 youget 可以轻松下载互联网上的视频、图片和音乐。

youget库的使用:方法一:直接下载

文件默认保存地址为C盘用户目录

方法二:下载定义对应的视频文件

% 查看视频文件的清晰度

you-get -i + 目标网页网址

% 选择所需的清晰度

you-get --format=对应的清晰度 + 目标网页网址

补充:

% 下载视频重命名

you-get 目标网页网址 -O 文件名(不用加文件扩展名)

% you-get https://v.qq.com/x/page/b081967rklt.html -O demo

% 指定下载路径(两种方式都行)

you-get 目标网页网址 -O 文件路径\文件名(不用加文件扩展名)

you-get 目标网页网址 -O 文件路径\文件名(不用加文件扩展名)

你得到常见的错误处理

对于B站的部分视频,如果我们直接复制浏览器地址栏中的链接,运行结果可能会提示:

【这里需要一点前端基础,使用抓包工具获取视频文件正确的url,可以结合网络中的请求头信息下载,可以理解youget作为爬虫]

在浏览器中按F12(或Fn+F12)打开开发者工具,以Firefox为例,在查看器下找到head标签,找到类似下图的语句:

使用此语句中的 URL 作为下载 URL

4.使用爬虫爬取

网络爬虫是一种高效的信息采集器,您可以使用它快速准确地采集我们想要的任何数据源。

示例:知乎热门列表文本数据采集并写入文件

作为Python爬虫爱好者,笔者将在后续开专栏整理补充关于Python爬虫的相关文章。想了解爬虫的朋友可以关注和留言。 查看全部

网页视频抓取浏览器(补充有关Python爬虫的网络资料的抓取方式(2))

(2)文件导入:

打开扩展页面的开发者模式,可以直接点击加载,也可以拖拽对应文件到扩展页面完成安装

2.浏览器插件

以火狐浏览器为例,可以下载相关插件抓取网络数据

方法一:网站搜索下载

a) Firefox 插件的浏览器搜索

b) 在 网站 下载并启用 Video DownloadHelper

中找到所需的浏览器扩展

方法二:按名称搜索下载

3.Python-youget 库下载

youget 是 Python 的第三方库,也是一款优秀的网站视频下载工具。使用 youget 可以轻松下载互联网上的视频、图片和音乐。

youget库的使用:方法一:直接下载

文件默认保存地址为C盘用户目录

方法二:下载定义对应的视频文件

% 查看视频文件的清晰度

you-get -i + 目标网页网址

% 选择所需的清晰度

you-get --format=对应的清晰度 + 目标网页网址

补充:

% 下载视频重命名

you-get 目标网页网址 -O 文件名(不用加文件扩展名)

% you-get https://v.qq.com/x/page/b081967rklt.html -O demo

% 指定下载路径(两种方式都行)

you-get 目标网页网址 -O 文件路径\文件名(不用加文件扩展名)

you-get 目标网页网址 -O 文件路径\文件名(不用加文件扩展名)

你得到常见的错误处理

对于B站的部分视频,如果我们直接复制浏览器地址栏中的链接,运行结果可能会提示:

【这里需要一点前端基础,使用抓包工具获取视频文件正确的url,可以结合网络中的请求头信息下载,可以理解youget作为爬虫]

在浏览器中按F12(或Fn+F12)打开开发者工具,以Firefox为例,在查看器下找到head标签,找到类似下图的语句:

使用此语句中的 URL 作为下载 URL

4.使用爬虫爬取

网络爬虫是一种高效的信息采集器,您可以使用它快速准确地采集我们想要的任何数据源。

示例:知乎热门列表文本数据采集并写入文件

作为Python爬虫爱好者,笔者将在后续开专栏整理补充关于Python爬虫的相关文章。想了解爬虫的朋友可以关注和留言。

网页视频抓取浏览器(python爬虫与项目实战,网络爬虫是一个自动提取网页的程序)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-01-22 08:18

Python爬虫与项目实战,网络爬虫是一个自动提取网页的程序,它从万维网上下载网页供搜索引擎使用,是搜索引擎的重要组成部分。随着网络的飞速发展,万维网已经成为大量信息的载体,如何有效地提取和利用这些信息成为了巨大的挑战。搜索引擎(Search Engine),如传统的通用搜索引擎AltaVista、Yahoo!而谷歌等作为帮助人们检索信息的工具,已经成为用户访问万维网的门户和指南。但是这些通用搜索引擎也有一定的局限性,比如:(1)不同领域和背景的用户往往有不同的检索目的和需求,一般搜索引擎返回的结果中收录大量用户并不关心的网页。(2)通用搜索引擎的目标是最大化网络覆盖,有限的搜索引擎服务器资源和无限的网络数据资源之间的冲突将进一步加深。(3)随着数据形式的丰富万维网和网络技术的不断发展,出现了大量的图片、数据库、音频、视频和多媒体等不同的数据,而一般的搜索引擎往往对这些信息内容密集、具有一定结构的数据无能为力,并且不能很好的发现和获取。.(4)一般搜索引擎大多提供基于关键词的检索,难以支持基于语义信息的查询。为了解决上述问题,出现了定向爬取相关网络资源的专注爬虫。Focused crawlers 是一个自动下载网页的程序。它根据给定的爬取目标有选择地访问万维网上的网页和相关链接,以获取所需的信息。与通用网络爬虫不同,专注爬虫不追求大覆盖,目标是爬取与特定主题内容相关的网页,为面向主题的用户查询准备数据资源。传统爬虫从一个或多个URL开始初始网页获取初始网页上的URL,在抓取网页的过程中,不断地从当前页面中提取新的URL并放入队列中。直到满足系统的某个停止条件。焦点爬虫的工作流程比较复杂。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。它会按照一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。它会按照一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。并为后续查询和检索编制索引;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。并为后续查询和检索编制索引;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。 查看全部

网页视频抓取浏览器(python爬虫与项目实战,网络爬虫是一个自动提取网页的程序)

Python爬虫与项目实战,网络爬虫是一个自动提取网页的程序,它从万维网上下载网页供搜索引擎使用,是搜索引擎的重要组成部分。随着网络的飞速发展,万维网已经成为大量信息的载体,如何有效地提取和利用这些信息成为了巨大的挑战。搜索引擎(Search Engine),如传统的通用搜索引擎AltaVista、Yahoo!而谷歌等作为帮助人们检索信息的工具,已经成为用户访问万维网的门户和指南。但是这些通用搜索引擎也有一定的局限性,比如:(1)不同领域和背景的用户往往有不同的检索目的和需求,一般搜索引擎返回的结果中收录大量用户并不关心的网页。(2)通用搜索引擎的目标是最大化网络覆盖,有限的搜索引擎服务器资源和无限的网络数据资源之间的冲突将进一步加深。(3)随着数据形式的丰富万维网和网络技术的不断发展,出现了大量的图片、数据库、音频、视频和多媒体等不同的数据,而一般的搜索引擎往往对这些信息内容密集、具有一定结构的数据无能为力,并且不能很好的发现和获取。.(4)一般搜索引擎大多提供基于关键词的检索,难以支持基于语义信息的查询。为了解决上述问题,出现了定向爬取相关网络资源的专注爬虫。Focused crawlers 是一个自动下载网页的程序。它根据给定的爬取目标有选择地访问万维网上的网页和相关链接,以获取所需的信息。与通用网络爬虫不同,专注爬虫不追求大覆盖,目标是爬取与特定主题内容相关的网页,为面向主题的用户查询准备数据资源。传统爬虫从一个或多个URL开始初始网页获取初始网页上的URL,在抓取网页的过程中,不断地从当前页面中提取新的URL并放入队列中。直到满足系统的某个停止条件。焦点爬虫的工作流程比较复杂。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。它需要按照一定的网页分析算法过滤掉与主题无关的链接,保留有用的链接,并放入等待抓取的URL队列中。然后,它会根据一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。它会按照一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。它会按照一定的搜索策略从队列中选择下一个要爬取的网页URL,并重复上述过程,直到达到系统的一定条件并停止。此外,爬虫爬取的所有网页都会被系统存储,经过一定的分析、过滤、索引,以供后续查询和检索;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。并为后续查询和检索编制索引;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。并为后续查询和检索编制索引;对于重点爬虫来说,这个过程中得到的分析结果也可能对后续的爬取过程给出反馈和指导。

网页视频抓取浏览器( scrapy调度器的处理方法和处理的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-01-21 08:14

scrapy调度器的处理方法和处理的方法)

1.scrapy 框架有多少个组件/模块?

Scrapy Engine:这是引擎,负责Spiders、ItemPipeline、Downloader、Scheduler、信号、数据传输等等之间的通信!(像人体?)

调度器(Scheduler):负责接受引擎发送的请求,并按一定的方式安排,加入队列,等待来自Scrapy Engine(引擎)的请求,交给引擎。

Downloader(下载器):负责下载Scrapy Engine(引擎)发出的所有Requests请求,并将得到的Responses返回给Scrapy Engine(引擎),交给Spiders引擎处理,

Spiders:负责处理所有的Response,分析并从中提取数据,获取Item字段需要的数据,将需要跟进的URL提交给引擎,再次进入Scheduler。

Item Pipeline:负责处理从Spiders获取的Item,并对其进行处理,如去重、持久化存储(保存数据库、写入文件,总之就是用来保存数据的)

Downloader Middlewares:可以把它看成一个可以自定义和扩展下载功能的组件

2.scrapy 工作流程的简要说明。

整个 Scrapy 的数据流:

程序运行时,

发动机:嗨!蜘蛛,你在对付哪个网站?

蜘蛛:我必须对付

引擎:给我你需要的第一个处理的 URL。

蜘蛛:给你的第一个网址是

发动机:嗨!调度员,我这里有一个请求,请帮我排序并加入队列。

调度程序:好的,正在处理您等一下。

发动机:嗨!调度员,给我你处理过的请求,

调度器:给你,这是我处理的请求

发动机:嗨!下载器,帮我根据下载中间件的设置下载这个请求

下载者:好的!给你,这是下载的东西。(如果失败:对不起,这个请求下载失败,然后引擎告诉调度器这个请求下载失败,你记录一下,我们稍后下载。)

发动机:嗨!蜘蛛,这是下载的东西,已经按照蜘蛛中间件处理了,你可以处理(注意!这里的响应默认由def parse函数处理)

蜘蛛:(对于处理数据后需要跟进的URL),您好!引擎,这是我需要跟进的 URL,并将其响应传递给函数 def xxxx(self,responses) 进行处理。这就是我得到的物品。

发动机:嗨!项目管道我这里有一个项目,请帮我处理它!调度器!这是我需要你帮我处理的 URL。然后从第4步循环,直到你得到你需要的信息,注意!只有当调度器中没有请求时,整个程序才会停止,(即对于下载失败的URL,Scrapy会重新下载。)

3.scrapy指纹去重原理和scrapy-redis去重原理?

Scrapy的去重原理流程:使用哈希值和集合去重。首先创建fingerprint = set() 组合,然后使用请求对象的sha1对象来消化信息。摘要完成后,判断哈希值是否在集合中。如果是,则返回 true,如果不是,则将其添加到集合中。

scrapy-redis的去重原理基本相同,只是持久化存储在redis共享数据库中。当请求的数据达到10亿级以上时,此时会消耗大量内存。一个 40 字节的 sha1 会占用 40G 的内存,大部分存储这个数据的数据库都无法承受。这时候应该使用布隆过滤器。

4.请简单介绍一下scrapy框架。

scrapy 是一个快速、高级的基于 python 的网络爬虫框架,用于爬取网站并从页面中提取结构化数据。scrapy 使用 Twisted 异步网络库来处理网络通信。

5.为什么要使用scrapy框架?scrapy框架有什么优势?

更容易构建大规模的抓取项目

它异步处理请求并且非常快

采用自动调节机构,可自动调节爬行速度

6.scrapy如何实现分布式爬取?

它可以在 scrapy_redis 类库的帮助下实现。

分布式爬虫时,会有master和slave,其中master是核心服务器,slave是具体的爬虫服务器。

我们在主服务器上搭建一个redis数据库,将要爬取的url存储在redis数据库中。所有从爬虫服务器在爬取时都从redis数据库链接。由于scrapy_redis自身的队列机制,slave获取的url不会相互冲突,然后最终将获取到的结果存入数据库。捕获的 URL 的指纹也存储在 master 的 redis 数据库中以进行重复数据删除。相关代码可以在 dupefilter.py 文件中的 request_seen() 方法中找到。

去重问题:

dupefilter.py 中的源代码:

def request_seen(self, request):

fp = request_fingerprint(请求)

添加 = self.server.sadd(self.key, fp)

返回未添加

去重是通过将请求的指纹存储在redis上来实现的。

7.使用scrapy 和requests?

请求是轮询的,会被网络阻塞,不适合爬取大量数据

scapy底层是twisted异步框架,并发是最大优势

8.爬虫用多线程好不好?还是更多进程?为什么?

对于IO密集型代码(文件处理、网络爬虫),多线程可以有效提高效率(单线程下的IO操作会导致IO等待,会造成不必要的等待时间。启用多线程后,当线程A等待,会自动切换到线程B,不会浪费CPU资源,从而提高程序执行效率)。

在实际的采集进程中,要设置多进程或多线程,不仅要考虑网速和相应的问题,还要考虑本机硬件的情况。

9.了解哪些基于爬虫的模块?

网络请求:urllib、requests、aiohttp

数据解析:re、xpath、bs4、pyquery

硒

js反向:pyexcJs

10.列举爬取过程中遇到哪些比较难的反爬机制?

动态加载的数据

动态改变请求参数

js加密

演戏

饼干

11.简述如何抓取动态加载数据?

基于抓包工具的全局搜索

如果动态加载的数据是密文,则无法搜索到全局搜索

12.如何抓取手机数据?

提琴手,appnium,网络配置

13.如何实现全站数据爬取?

基于手动请求发送+递归解析

基于 CrwalSpider (LinkExtractor, Rule)

14.如何提高爬取数据的效率?

使用框架

线程池,多任务异步协程

分散式

15.列出你接触的防爬机制?

从功能上来说,爬虫一般分为数据采集、处理、存储三部分。这里我们只讨论 data采集 部分。

一般网站反爬虫从三个方面:用户请求的头文件、用户行为、网站目录和数据加载方式。前两种比较容易遇到,从这些角度来看,大部分网站都是反爬虫。会使用第三种使用ajax的网站,增加了爬取的难度。

1)通过Headers反爬虫

反爬取用户请求的头部是最常见的反爬取策略。很多网站会检测Headers的User-Agent,有的网站会检测Referer(有些资源的防盗链网站就是检测Referer)。如果遇到这样的反爬虫机制,可以直接在爬虫中添加Headers,将浏览器的User-Agent复制到爬虫的Headers中;或者将Referer值改为目标网站域名。对于检测Headers的反爬虫,在爬虫中修改或添加Headers可以很好的绕过。

2)基于用户行为的反爬虫

网站的另一部分是检测用户行为,比如同一IP在短时间内多次访问同一页面,或者同一账号在短时间内多次执行同一操作。大多数网站都是前一种情况,使用IP代理就可以了。可以专门写一个爬虫来爬取网上公开的代理ip,检测到后全部保存。这样的代理ip爬虫经常使用,最好自己准备一个。有大量代理IP,可以每隔几次更换一个IP,这在requests或者urllib2中很容易做到,这样就可以轻松绕过第一个反爬虫。

对于第二种情况,下一个请求可以在每个请求之后以几秒的随机间隔发出。一些有逻辑漏洞的网站可以通过多次请求、注销、重新登录、继续请求的方式绕过同一账号短时间内不能多次请求的限制。

3)动态页面的反爬虫

以上情况大多出现在静态页面中,也有一些网站,我们需要爬取的数据是通过ajax请求获取的,或者通过JavaScript生成的。首先使用 Firebug 或 HttpFox 分析网络请求。

如果我们能找到ajax请求并分析出具体参数和响应的具体含义,就可以使用上面的方法,直接使用requests或者urllib2来模拟ajax请求,分析响应json得到需要的数据。

能够直接模拟ajax请求获取数据是很棒的,但是有的网站把ajax请求的所有参数都加密了。我们根本无法构造对我们需要的数据的请求。我这几天爬的网站就是这样的。除了对ajax参数进行加密外,还封装了一些基础功能,都是调用自己的接口,接口参数是加密的。遇到这样的网站,我们就不能使用上面的方法了。我使用selenium+phantomJS框架调用浏览器内核,使用phantomJS执行js模拟人类操作,触发页面中的js脚本。从填表到点击按钮再到页面滚动,都可以模拟,不管具体的请求和响应过程,

使用这个框架几乎可以绕过大部分反爬虫,因为它不是冒充浏览器获取数据(上面提到的添加header在一定程度上是冒充浏览器),它本身就是浏览器,而且phantomJS 是一个没有界面的浏览器,但控制浏览器的不是人。使用selenium+phantomJS可以做很多事情,比如识别触摸类型(12306)或者滑动类型的验证码,页面表单的暴力破解等)。它还将在自动化渗透中发挥重要作用,并将在未来发挥作用。提到这一点。

16.什么是深度优先和广度优先(优缺点)

默认情况下,scrapy 是深度优先的。

深度优先:占用空间大,但跑得快。

广度优先:占用空间少,运行慢

17.知道谷歌的无头浏览器吗?

无头浏览器或无头浏览器是没有界面的浏览器。既然是浏览器,它应该有浏览器应该有的一切,却看不到界面。

Python中selenium模块中的PhantomJS是无界面浏览器(headless browser):它是基于QtWebkit的无头浏览器。

18.说说Scrapy的优缺点。

优势:

scrapy 是异步的

采用更具可读性的 xpath 而不是正则表达式

强大的统计和日志系统

同时爬取不同的网址

支持shell模式,方便独立调试

编写中间件,方便编写一些统一的过滤器

通过管道方式存储在数据库中

缺点:基于Python的爬虫框架,扩展性差

基于twisted框架,运行异常不会杀死reactor,异步框架出错后也不会停止其他任务,很难检测到数据错误。

19.需要登录的网页,如何解决ip、cookie、session同时限制?

解决IP的限制,可以使用代理IP地址池和服务器;如果动态爬取不适用,可以使用反编译的js文件获取对应的文件,或者切换到其他平台(如手机)看能否获取对应的json文件。.

20.验证码的解决方法?

1.输入验证码

解决方法:这个是最简单的,只要识别出里面的内容,然后在输入框内填写即可。这种识别技术叫做OCR,这里我们推荐使用Python的第三方库tesserocr。对于后面没有影响的验证码,可以通过这个库直接识别。但是对于背景嘈杂的验证码,直接识别的识别率会很低。这种情况下,我们需要先对图片进行处理,先对图片进行灰度化,然后二值化,再去识别,识别率会大大提高。

验证码识别大致步骤:

转换为灰度

去除背景噪音

图像分割

2.滑动验证码

解决方法:这种验证码比较复杂,但是有相应的方法。我们直接想到的就是模拟人拖动验证码的行为,点击按钮,然后看到缝隙的位置,最后把拼图拖到缝隙位置完成验证。

第一步:点击按钮。然后我们发现notch和puzzle在你没有点击按钮的时候并没有出现,只有在点击之后才出现,这给了我们寻找notch位置的灵感。

步骤 2:拖动到间隙位置。我们知道拼图应该拖到缺口处,但是这个距离怎么能用数值来表示呢?根据我们在第一步中观察到的情况,我们可以找到间隙的位置。这里我们可以比较两张图片的像素,设置一个参考值。如果某个位置的差异超过了参考值,那么我们就找到了两张图片的不同位置。当然,我们来自难题的右侧。它从侧面开始,从左到右。当找到第一个不同的位置时结束。这个位置应该是缝隙的左边,所以我们可以用selenium把它拖到这个位置。这里的另一个问题是如何自动保存这两个图像?这里我们可以先找到label,然后得到它的位置和大小,然后是top,bottom,left,right = location['y'] ,location['y']+size['height']+location['x'] + size['width'] ,然后截图,最后把这四个位置填上。具体使用可以查看selenium文档,点击按钮剪切图片,再点击剪切图片。最后,拖动时,需要模拟人类行为,先加速后减速。因为这种验证码有行为特征检测,所以人不可能一直保持匀速,否则会判断机器在拖拽,所以不会通过验证。可以查看selenium文档,点击按钮剪切图片,再点击剪切图片。最后,拖动时,需要模拟人类行为,先加速后减速。因为这种验证码有行为特征检测,所以人不可能一直保持匀速,否则会判断机器在拖拽,所以不会通过验证。可以查看selenium文档,点击按钮剪切图片,再点击剪切图片。最后,拖动时,需要模拟人类行为,先加速后减速。因为这种验证码有行为特征检测,所以人不可能一直保持匀速,否则会判断机器在拖拽,所以不会通过验证。

3.点击文本验证和图标选择

图文验证:通过文字提醒用户点击图片中相同单词的位置进行验证。

图标选择:给定一组图片,根据需要单击其中的一个或多个。借识别万物之难挡机器。

这两个原理是类似的,只是一个是给文字,点击图片中的文字,另一个是给图片,点击内容相同的图片。

这两种方法都不是特别好。您只能使用第三方识别接口来识别相同的内容。推荐一个超级鹰,发送验证码,会返回对应的点击坐标。然后使用 selenium 模拟点击。图片的获取方法同上面的方法。

21.如何破解滑动验证码?

破解核心思想:

1、如何判断滑块滑动多远?

滑块的滑动距离,需要检测验证码图片的间隙位置

滑动距离=终点坐标-起点坐标

那么问题就变成了我们需要截图,根据selenium中的位置方法,做一些坐标计算得到我们需要的位置

2、我们如何获得坐标?

起点坐标:

每次运行程序,位置都是固定的,滑块左边框距离验证码图片左边框6px。

终点坐标:

每次运行程序,位置都会发生变化,我们需要计算每个间隙的位置

如何计算终点是间隙的位置?

我们先举个例子。比如下面两张图片是120x60的图片,一张是纯色的图片,一张是有蓝线的图片(蓝线的位置是提前设置为60px的),我现在让你编程确定蓝线的位置,如何确定?

回答:

遍历所有像素点的颜色值,找到颜色值不同的点的位置,确定蓝线的位置

这句话怎么理解?点击下图,你有没有发现图片是由一个个像素组成的?对于 120×60 的图片,对应的像素为横轴 120 像素,纵轴 60 像素。我们需要遍历两张图片的坐标,比较颜色值,从(0,0)(0,1)...直到(120,60)),开始比较两者图片) 的颜色值,如果颜色值不同,我们可以回到这个位置

22.数据是如何存储的?

以 json 格式保存到文本文件

这是最简单、最方便、最常用的存储方法。json 格式确保您在打开文件时可以直观地检查存储的数据。一个数据存储在一行中。此方法适用于爬取少量数据。,后续的阅读分析也很方便。

保存到excel

如果爬取的数据很容易组织成表格的形式,那么将其存储在excel中是一个不错的选择。打开excel后,观察数据更方便。Excel也可以做一些简单的操作,可以用xlwt来写excel。在这个库中,xlrd 可以用来读取 excel。和方法一一样,excel中存储的数据不宜过多。另外,如果是多线程爬取,多线程写excel是不可能的。这是一个限制。

存储到 sqlite

sqlite不需要安装,是零配置的数据库,比mysql轻很多。语法方面,只要你懂mysql,操作sqlite是没有问题的。当爬虫数据量大,需要持久化存储,又懒得安装mysql的时候,sqlite绝对是最好的选择,不多,不支持多进程读写,所以不适合多进程爬虫。

存储到mysql数据库

MySQL 可以远程访问,但是 sqlite 不能,这意味着您可以将数据存储在远程服务器主机上。当数据量很大的时候,自然会选择mysql而不是sqlite,但是不管是mysql还是sqlite,在存储数据之前先建表,根据要抓取的数据结构和内容定义字段,这是耐心和精力的问题

存储到 mongodb

我最喜欢nosql数据库的原因之一是不需要像关系数据库那样定义表结构,因为定义表结构很麻烦。要确定字段的类型,varchar 类型的数据也需要定义长度。, 数据过长会被截断。

mongodb 以文档的形式存储数据。可以使用pymongo库直接将数据以json格式写入mongodb。即使是同一个集合,对数据的格式也没有要求,太灵活了。

刚刚捕获的数据通常需要清洗两次才能使用。如果使用关系型数据库存储数据,第一次需要定义表结构。清洗后,恐怕需要定义一个表结构来重新创建清洗后的数据。存储,太繁琐,使用mongodb省去了重复定义表结构的过程。

23.cookie过期有什么问题?

此时,cookie 需要自动更新。cookie 通常如何自动更新?这里将使用硒。

步骤1、使用selenium自动登录获取cookies并保存到文件中;

Step 2、 读取cookie,比较cookie的有效期,过期则再次执行步骤1;

Step 3、 请求其他网页时,填写cookie,保持登录状态。

24.Selenium 和 PhantomJS

硒

Selenium 是用于 Web 应用程序测试的工具。Selenium 测试直接在浏览器中运行,就像真正的用户一样。支持的浏览器包括IE(7、8、9、10、11)、Mozilla Firefox、Safari、Google Chrome、Opera等主流浏览器。该工具的主要功能包括:测试与浏览器的兼容性

- 测试您的应用程序,看看它是否在不同的浏览器和操作系统上运行良好。

它的功能是:

框架底层使用 JavaScript 模拟真实用户操作浏览器。执行测试脚本时,浏览器会自动根据脚本代码进行点击、进入、打开、验证等操作,就像真实用户一样,站在最终用户的角度对应用进行测试。

使自动化浏览器兼容性测试成为可能,尽管浏览器之间仍然存在细微差别。

使用简单,用例脚本可以用Java、Python等多种语言编写。

也就是说,它可以像真人一样根据指令访问浏览器,比如打开网页、截图等功能。

幻影

(新版本的 selenium 已经开始弃用 phantomjs,但有时我们可以单独使用它)是一个基于 Webkit 的无界面浏览器,将 网站 内容加载到内存中并执行页面上的各种脚本(如 js)。

25.如何判断网站是否更新? 查看全部

网页视频抓取浏览器(

scrapy调度器的处理方法和处理的方法)

1.scrapy 框架有多少个组件/模块?

Scrapy Engine:这是引擎,负责Spiders、ItemPipeline、Downloader、Scheduler、信号、数据传输等等之间的通信!(像人体?)

调度器(Scheduler):负责接受引擎发送的请求,并按一定的方式安排,加入队列,等待来自Scrapy Engine(引擎)的请求,交给引擎。

Downloader(下载器):负责下载Scrapy Engine(引擎)发出的所有Requests请求,并将得到的Responses返回给Scrapy Engine(引擎),交给Spiders引擎处理,

Spiders:负责处理所有的Response,分析并从中提取数据,获取Item字段需要的数据,将需要跟进的URL提交给引擎,再次进入Scheduler。

Item Pipeline:负责处理从Spiders获取的Item,并对其进行处理,如去重、持久化存储(保存数据库、写入文件,总之就是用来保存数据的)

Downloader Middlewares:可以把它看成一个可以自定义和扩展下载功能的组件

2.scrapy 工作流程的简要说明。

整个 Scrapy 的数据流:

程序运行时,

发动机:嗨!蜘蛛,你在对付哪个网站?

蜘蛛:我必须对付

引擎:给我你需要的第一个处理的 URL。

蜘蛛:给你的第一个网址是

发动机:嗨!调度员,我这里有一个请求,请帮我排序并加入队列。

调度程序:好的,正在处理您等一下。

发动机:嗨!调度员,给我你处理过的请求,

调度器:给你,这是我处理的请求

发动机:嗨!下载器,帮我根据下载中间件的设置下载这个请求

下载者:好的!给你,这是下载的东西。(如果失败:对不起,这个请求下载失败,然后引擎告诉调度器这个请求下载失败,你记录一下,我们稍后下载。)

发动机:嗨!蜘蛛,这是下载的东西,已经按照蜘蛛中间件处理了,你可以处理(注意!这里的响应默认由def parse函数处理)

蜘蛛:(对于处理数据后需要跟进的URL),您好!引擎,这是我需要跟进的 URL,并将其响应传递给函数 def xxxx(self,responses) 进行处理。这就是我得到的物品。

发动机:嗨!项目管道我这里有一个项目,请帮我处理它!调度器!这是我需要你帮我处理的 URL。然后从第4步循环,直到你得到你需要的信息,注意!只有当调度器中没有请求时,整个程序才会停止,(即对于下载失败的URL,Scrapy会重新下载。)

3.scrapy指纹去重原理和scrapy-redis去重原理?

Scrapy的去重原理流程:使用哈希值和集合去重。首先创建fingerprint = set() 组合,然后使用请求对象的sha1对象来消化信息。摘要完成后,判断哈希值是否在集合中。如果是,则返回 true,如果不是,则将其添加到集合中。

scrapy-redis的去重原理基本相同,只是持久化存储在redis共享数据库中。当请求的数据达到10亿级以上时,此时会消耗大量内存。一个 40 字节的 sha1 会占用 40G 的内存,大部分存储这个数据的数据库都无法承受。这时候应该使用布隆过滤器。

4.请简单介绍一下scrapy框架。

scrapy 是一个快速、高级的基于 python 的网络爬虫框架,用于爬取网站并从页面中提取结构化数据。scrapy 使用 Twisted 异步网络库来处理网络通信。

5.为什么要使用scrapy框架?scrapy框架有什么优势?

更容易构建大规模的抓取项目

它异步处理请求并且非常快

采用自动调节机构,可自动调节爬行速度

6.scrapy如何实现分布式爬取?

它可以在 scrapy_redis 类库的帮助下实现。

分布式爬虫时,会有master和slave,其中master是核心服务器,slave是具体的爬虫服务器。

我们在主服务器上搭建一个redis数据库,将要爬取的url存储在redis数据库中。所有从爬虫服务器在爬取时都从redis数据库链接。由于scrapy_redis自身的队列机制,slave获取的url不会相互冲突,然后最终将获取到的结果存入数据库。捕获的 URL 的指纹也存储在 master 的 redis 数据库中以进行重复数据删除。相关代码可以在 dupefilter.py 文件中的 request_seen() 方法中找到。

去重问题:

dupefilter.py 中的源代码:

def request_seen(self, request):

fp = request_fingerprint(请求)

添加 = self.server.sadd(self.key, fp)

返回未添加

去重是通过将请求的指纹存储在redis上来实现的。

7.使用scrapy 和requests?

请求是轮询的,会被网络阻塞,不适合爬取大量数据

scapy底层是twisted异步框架,并发是最大优势

8.爬虫用多线程好不好?还是更多进程?为什么?

对于IO密集型代码(文件处理、网络爬虫),多线程可以有效提高效率(单线程下的IO操作会导致IO等待,会造成不必要的等待时间。启用多线程后,当线程A等待,会自动切换到线程B,不会浪费CPU资源,从而提高程序执行效率)。

在实际的采集进程中,要设置多进程或多线程,不仅要考虑网速和相应的问题,还要考虑本机硬件的情况。

9.了解哪些基于爬虫的模块?

网络请求:urllib、requests、aiohttp

数据解析:re、xpath、bs4、pyquery

硒

js反向:pyexcJs

10.列举爬取过程中遇到哪些比较难的反爬机制?

动态加载的数据

动态改变请求参数

js加密

演戏

饼干

11.简述如何抓取动态加载数据?

基于抓包工具的全局搜索

如果动态加载的数据是密文,则无法搜索到全局搜索

12.如何抓取手机数据?

提琴手,appnium,网络配置

13.如何实现全站数据爬取?

基于手动请求发送+递归解析

基于 CrwalSpider (LinkExtractor, Rule)

14.如何提高爬取数据的效率?

使用框架

线程池,多任务异步协程

分散式

15.列出你接触的防爬机制?

从功能上来说,爬虫一般分为数据采集、处理、存储三部分。这里我们只讨论 data采集 部分。

一般网站反爬虫从三个方面:用户请求的头文件、用户行为、网站目录和数据加载方式。前两种比较容易遇到,从这些角度来看,大部分网站都是反爬虫。会使用第三种使用ajax的网站,增加了爬取的难度。

1)通过Headers反爬虫

反爬取用户请求的头部是最常见的反爬取策略。很多网站会检测Headers的User-Agent,有的网站会检测Referer(有些资源的防盗链网站就是检测Referer)。如果遇到这样的反爬虫机制,可以直接在爬虫中添加Headers,将浏览器的User-Agent复制到爬虫的Headers中;或者将Referer值改为目标网站域名。对于检测Headers的反爬虫,在爬虫中修改或添加Headers可以很好的绕过。

2)基于用户行为的反爬虫

网站的另一部分是检测用户行为,比如同一IP在短时间内多次访问同一页面,或者同一账号在短时间内多次执行同一操作。大多数网站都是前一种情况,使用IP代理就可以了。可以专门写一个爬虫来爬取网上公开的代理ip,检测到后全部保存。这样的代理ip爬虫经常使用,最好自己准备一个。有大量代理IP,可以每隔几次更换一个IP,这在requests或者urllib2中很容易做到,这样就可以轻松绕过第一个反爬虫。

对于第二种情况,下一个请求可以在每个请求之后以几秒的随机间隔发出。一些有逻辑漏洞的网站可以通过多次请求、注销、重新登录、继续请求的方式绕过同一账号短时间内不能多次请求的限制。

3)动态页面的反爬虫

以上情况大多出现在静态页面中,也有一些网站,我们需要爬取的数据是通过ajax请求获取的,或者通过JavaScript生成的。首先使用 Firebug 或 HttpFox 分析网络请求。

如果我们能找到ajax请求并分析出具体参数和响应的具体含义,就可以使用上面的方法,直接使用requests或者urllib2来模拟ajax请求,分析响应json得到需要的数据。

能够直接模拟ajax请求获取数据是很棒的,但是有的网站把ajax请求的所有参数都加密了。我们根本无法构造对我们需要的数据的请求。我这几天爬的网站就是这样的。除了对ajax参数进行加密外,还封装了一些基础功能,都是调用自己的接口,接口参数是加密的。遇到这样的网站,我们就不能使用上面的方法了。我使用selenium+phantomJS框架调用浏览器内核,使用phantomJS执行js模拟人类操作,触发页面中的js脚本。从填表到点击按钮再到页面滚动,都可以模拟,不管具体的请求和响应过程,

使用这个框架几乎可以绕过大部分反爬虫,因为它不是冒充浏览器获取数据(上面提到的添加header在一定程度上是冒充浏览器),它本身就是浏览器,而且phantomJS 是一个没有界面的浏览器,但控制浏览器的不是人。使用selenium+phantomJS可以做很多事情,比如识别触摸类型(12306)或者滑动类型的验证码,页面表单的暴力破解等)。它还将在自动化渗透中发挥重要作用,并将在未来发挥作用。提到这一点。

16.什么是深度优先和广度优先(优缺点)

默认情况下,scrapy 是深度优先的。

深度优先:占用空间大,但跑得快。

广度优先:占用空间少,运行慢

17.知道谷歌的无头浏览器吗?

无头浏览器或无头浏览器是没有界面的浏览器。既然是浏览器,它应该有浏览器应该有的一切,却看不到界面。

Python中selenium模块中的PhantomJS是无界面浏览器(headless browser):它是基于QtWebkit的无头浏览器。

18.说说Scrapy的优缺点。

优势:

scrapy 是异步的

采用更具可读性的 xpath 而不是正则表达式

强大的统计和日志系统

同时爬取不同的网址

支持shell模式,方便独立调试

编写中间件,方便编写一些统一的过滤器

通过管道方式存储在数据库中

缺点:基于Python的爬虫框架,扩展性差

基于twisted框架,运行异常不会杀死reactor,异步框架出错后也不会停止其他任务,很难检测到数据错误。

19.需要登录的网页,如何解决ip、cookie、session同时限制?

解决IP的限制,可以使用代理IP地址池和服务器;如果动态爬取不适用,可以使用反编译的js文件获取对应的文件,或者切换到其他平台(如手机)看能否获取对应的json文件。.

20.验证码的解决方法?

1.输入验证码

解决方法:这个是最简单的,只要识别出里面的内容,然后在输入框内填写即可。这种识别技术叫做OCR,这里我们推荐使用Python的第三方库tesserocr。对于后面没有影响的验证码,可以通过这个库直接识别。但是对于背景嘈杂的验证码,直接识别的识别率会很低。这种情况下,我们需要先对图片进行处理,先对图片进行灰度化,然后二值化,再去识别,识别率会大大提高。

验证码识别大致步骤:

转换为灰度

去除背景噪音

图像分割

2.滑动验证码

解决方法:这种验证码比较复杂,但是有相应的方法。我们直接想到的就是模拟人拖动验证码的行为,点击按钮,然后看到缝隙的位置,最后把拼图拖到缝隙位置完成验证。

第一步:点击按钮。然后我们发现notch和puzzle在你没有点击按钮的时候并没有出现,只有在点击之后才出现,这给了我们寻找notch位置的灵感。

步骤 2:拖动到间隙位置。我们知道拼图应该拖到缺口处,但是这个距离怎么能用数值来表示呢?根据我们在第一步中观察到的情况,我们可以找到间隙的位置。这里我们可以比较两张图片的像素,设置一个参考值。如果某个位置的差异超过了参考值,那么我们就找到了两张图片的不同位置。当然,我们来自难题的右侧。它从侧面开始,从左到右。当找到第一个不同的位置时结束。这个位置应该是缝隙的左边,所以我们可以用selenium把它拖到这个位置。这里的另一个问题是如何自动保存这两个图像?这里我们可以先找到label,然后得到它的位置和大小,然后是top,bottom,left,right = location['y'] ,location['y']+size['height']+location['x'] + size['width'] ,然后截图,最后把这四个位置填上。具体使用可以查看selenium文档,点击按钮剪切图片,再点击剪切图片。最后,拖动时,需要模拟人类行为,先加速后减速。因为这种验证码有行为特征检测,所以人不可能一直保持匀速,否则会判断机器在拖拽,所以不会通过验证。可以查看selenium文档,点击按钮剪切图片,再点击剪切图片。最后,拖动时,需要模拟人类行为,先加速后减速。因为这种验证码有行为特征检测,所以人不可能一直保持匀速,否则会判断机器在拖拽,所以不会通过验证。可以查看selenium文档,点击按钮剪切图片,再点击剪切图片。最后,拖动时,需要模拟人类行为,先加速后减速。因为这种验证码有行为特征检测,所以人不可能一直保持匀速,否则会判断机器在拖拽,所以不会通过验证。

3.点击文本验证和图标选择

图文验证:通过文字提醒用户点击图片中相同单词的位置进行验证。

图标选择:给定一组图片,根据需要单击其中的一个或多个。借识别万物之难挡机器。

这两个原理是类似的,只是一个是给文字,点击图片中的文字,另一个是给图片,点击内容相同的图片。

这两种方法都不是特别好。您只能使用第三方识别接口来识别相同的内容。推荐一个超级鹰,发送验证码,会返回对应的点击坐标。然后使用 selenium 模拟点击。图片的获取方法同上面的方法。

21.如何破解滑动验证码?

破解核心思想:

1、如何判断滑块滑动多远?

滑块的滑动距离,需要检测验证码图片的间隙位置

滑动距离=终点坐标-起点坐标

那么问题就变成了我们需要截图,根据selenium中的位置方法,做一些坐标计算得到我们需要的位置

2、我们如何获得坐标?

起点坐标:

每次运行程序,位置都是固定的,滑块左边框距离验证码图片左边框6px。

终点坐标:

每次运行程序,位置都会发生变化,我们需要计算每个间隙的位置

如何计算终点是间隙的位置?

我们先举个例子。比如下面两张图片是120x60的图片,一张是纯色的图片,一张是有蓝线的图片(蓝线的位置是提前设置为60px的),我现在让你编程确定蓝线的位置,如何确定?

回答:

遍历所有像素点的颜色值,找到颜色值不同的点的位置,确定蓝线的位置

这句话怎么理解?点击下图,你有没有发现图片是由一个个像素组成的?对于 120×60 的图片,对应的像素为横轴 120 像素,纵轴 60 像素。我们需要遍历两张图片的坐标,比较颜色值,从(0,0)(0,1)...直到(120,60)),开始比较两者图片) 的颜色值,如果颜色值不同,我们可以回到这个位置

22.数据是如何存储的?

以 json 格式保存到文本文件

这是最简单、最方便、最常用的存储方法。json 格式确保您在打开文件时可以直观地检查存储的数据。一个数据存储在一行中。此方法适用于爬取少量数据。,后续的阅读分析也很方便。

保存到excel

如果爬取的数据很容易组织成表格的形式,那么将其存储在excel中是一个不错的选择。打开excel后,观察数据更方便。Excel也可以做一些简单的操作,可以用xlwt来写excel。在这个库中,xlrd 可以用来读取 excel。和方法一一样,excel中存储的数据不宜过多。另外,如果是多线程爬取,多线程写excel是不可能的。这是一个限制。

存储到 sqlite

sqlite不需要安装,是零配置的数据库,比mysql轻很多。语法方面,只要你懂mysql,操作sqlite是没有问题的。当爬虫数据量大,需要持久化存储,又懒得安装mysql的时候,sqlite绝对是最好的选择,不多,不支持多进程读写,所以不适合多进程爬虫。

存储到mysql数据库

MySQL 可以远程访问,但是 sqlite 不能,这意味着您可以将数据存储在远程服务器主机上。当数据量很大的时候,自然会选择mysql而不是sqlite,但是不管是mysql还是sqlite,在存储数据之前先建表,根据要抓取的数据结构和内容定义字段,这是耐心和精力的问题

存储到 mongodb

我最喜欢nosql数据库的原因之一是不需要像关系数据库那样定义表结构,因为定义表结构很麻烦。要确定字段的类型,varchar 类型的数据也需要定义长度。, 数据过长会被截断。

mongodb 以文档的形式存储数据。可以使用pymongo库直接将数据以json格式写入mongodb。即使是同一个集合,对数据的格式也没有要求,太灵活了。

刚刚捕获的数据通常需要清洗两次才能使用。如果使用关系型数据库存储数据,第一次需要定义表结构。清洗后,恐怕需要定义一个表结构来重新创建清洗后的数据。存储,太繁琐,使用mongodb省去了重复定义表结构的过程。

23.cookie过期有什么问题?

此时,cookie 需要自动更新。cookie 通常如何自动更新?这里将使用硒。

步骤1、使用selenium自动登录获取cookies并保存到文件中;

Step 2、 读取cookie,比较cookie的有效期,过期则再次执行步骤1;

Step 3、 请求其他网页时,填写cookie,保持登录状态。

24.Selenium 和 PhantomJS

硒

Selenium 是用于 Web 应用程序测试的工具。Selenium 测试直接在浏览器中运行,就像真正的用户一样。支持的浏览器包括IE(7、8、9、10、11)、Mozilla Firefox、Safari、Google Chrome、Opera等主流浏览器。该工具的主要功能包括:测试与浏览器的兼容性

- 测试您的应用程序,看看它是否在不同的浏览器和操作系统上运行良好。

它的功能是:

框架底层使用 JavaScript 模拟真实用户操作浏览器。执行测试脚本时,浏览器会自动根据脚本代码进行点击、进入、打开、验证等操作,就像真实用户一样,站在最终用户的角度对应用进行测试。

使自动化浏览器兼容性测试成为可能,尽管浏览器之间仍然存在细微差别。

使用简单,用例脚本可以用Java、Python等多种语言编写。

也就是说,它可以像真人一样根据指令访问浏览器,比如打开网页、截图等功能。

幻影

(新版本的 selenium 已经开始弃用 phantomjs,但有时我们可以单独使用它)是一个基于 Webkit 的无界面浏览器,将 网站 内容加载到内存中并执行页面上的各种脚本(如 js)。

25.如何判断网站是否更新?

网页视频抓取浏览器(它会自动扫描IE、基于Mozilla的网页浏览器以便以后播放)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2022-01-17 08:28

VideoCacheView中文版下载,在线观看视频后,您可能希望将视频文件保存到硬盘以供以后观看。如果视频存储在浏览器的缓存文件夹中,该软件可以帮助您从缓存文件夹中找到视频文件并将其保存到另一个位置。

它会自动扫描 Internet Explorer、基于 Mozilla 的网络浏览器(包括 FireFox)的整个缓存文件夹,并查找当前存储在其中的所有视频文件。同时,该软件还可以让您轻松将视频缓存文件复制到其他文件夹,以供以后播放。如果您有播放 FLV 文件的播放器,该软件还允许您直接从缓存文件夹中播放文件。

指示

VideoCacheView是一款绿色软件,无需安装或附加DLL链接库,只需执行VideoCacheView.exe文件即可。运行 VideoCacheView 后,它会自动扫描您的 IE 或 Mozilla 浏览器的缓存目录,等待 5-30 秒扫描完成后,程序主窗口将显示缓存中的所有视频文件。

主窗口中的视频文件列表显示后,根据视频文件是否保存在本地缓存中,您可以选择以下不同的操作选项:

如果缓存中存在视频文件,可选择“播放所选文件”、“将所选文件复制到”等操作;

如果缓存中不存在视频文件,可以选择“在浏览器中打开下载地址”、“复制下载地址”等操作。

更新历史:

*版本3.08

更新以修复最新版 Chrome 中缓存分区字符串的使用。

*版本3.07

从 Firefox 修复。在最新版本中正确提取 URL 的问题

*版本3.06

更新为与 Chrome 的新缓存分区一起正常工作

*版本3.05

添加了“手动合并选定文件”选项 (Ctrl+M)。如果您拆分了 VideoCacheView 无法检测和合并的视频文件

可以自动选择所有项目,按Ctrl+M,VideoCacheView会将所有选择的项目合并为一个项目。

使用“手动合并选定文件”选项后,您可以使用“将选定文件复制到...”选项生成合并文件。请注意,合并文件的顺序是根据每个文件的创建时间确定的。

2.版本 63

已修复:VideoCacheView 表示 YouTube 将文件拆分为零文件大小,这有时会导致生成的合并文件损坏。 查看全部

网页视频抓取浏览器(它会自动扫描IE、基于Mozilla的网页浏览器以便以后播放)

VideoCacheView中文版下载,在线观看视频后,您可能希望将视频文件保存到硬盘以供以后观看。如果视频存储在浏览器的缓存文件夹中,该软件可以帮助您从缓存文件夹中找到视频文件并将其保存到另一个位置。

它会自动扫描 Internet Explorer、基于 Mozilla 的网络浏览器(包括 FireFox)的整个缓存文件夹,并查找当前存储在其中的所有视频文件。同时,该软件还可以让您轻松将视频缓存文件复制到其他文件夹,以供以后播放。如果您有播放 FLV 文件的播放器,该软件还允许您直接从缓存文件夹中播放文件。

指示

VideoCacheView是一款绿色软件,无需安装或附加DLL链接库,只需执行VideoCacheView.exe文件即可。运行 VideoCacheView 后,它会自动扫描您的 IE 或 Mozilla 浏览器的缓存目录,等待 5-30 秒扫描完成后,程序主窗口将显示缓存中的所有视频文件。

主窗口中的视频文件列表显示后,根据视频文件是否保存在本地缓存中,您可以选择以下不同的操作选项:

如果缓存中存在视频文件,可选择“播放所选文件”、“将所选文件复制到”等操作;

如果缓存中不存在视频文件,可以选择“在浏览器中打开下载地址”、“复制下载地址”等操作。

更新历史:

*版本3.08

更新以修复最新版 Chrome 中缓存分区字符串的使用。

*版本3.07

从 Firefox 修复。在最新版本中正确提取 URL 的问题

*版本3.06

更新为与 Chrome 的新缓存分区一起正常工作

*版本3.05

添加了“手动合并选定文件”选项 (Ctrl+M)。如果您拆分了 VideoCacheView 无法检测和合并的视频文件

可以自动选择所有项目,按Ctrl+M,VideoCacheView会将所有选择的项目合并为一个项目。

使用“手动合并选定文件”选项后,您可以使用“将选定文件复制到...”选项生成合并文件。请注意,合并文件的顺序是根据每个文件的创建时间确定的。

2.版本 63

已修复:VideoCacheView 表示 YouTube 将文件拆分为零文件大小,这有时会导致生成的合并文件损坏。

网页视频抓取浏览器(素材浏览器破解版app是一款非常实用的网页素材抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-01-13 13:26

素材浏览器破解版app是一款非常实用的网页素材抓取工具。其功能非常强大,内容非常丰富,深受广大用户的青睐!它有各种风格的素材内容,图片,视频,文章等等!用户可以在这里随意下载,非常方便!该软件的使用方法非常简单,您只需在此处打开各种URL内容,即可自动找到您需要的图片和文件内容,下载供您使用。素材浏览器破解版也是一款快速浏览器,帮助用户快速上网。它没有任何插件,体积很小。过滤所有广告内容,支持外网访问,无需登录即可使用。感兴趣的用户朋友快来下载使用吧!

软件特色1、素材浏览器破解版app支持一键下载和保存网页中的视频、图片、音频、文案等素材。

2、界面简洁,纯浏览,无广告无推广,观看舒适。

3、极速搜索引擎,提供高速上网体验,系统为您推荐相关词条。

4、轻松搜索,方便快捷,支持隐身浏览,使用时信息更安全。

软件功能1、智能搜索:无需手动输入,素材浏览器APP自动识别搜索链接,精彩网页瞬间呈现。

2、 海量素材:素材浏览器APP支持多平台素材搜索,高清原图、视频,免费下载。

3、音频提取:素材浏览器app可以从各种视频中提取音频,一键保存到手机中。

4、下载管理:素材浏览器APP支持批量保存网页图片、视频、音频、文案。软件亮点1、保存速度:拦截无效信息,节省大量流量;提供无图阅读模式,在流量受限时轻松浏览网页;

2、快速启动:素材浏览器破解版app启动快如闪电,退出后台无残留,安全浏览器就是安全浏览器;

3、简约设计:安全浏览器设计简洁舒适,页面清新干净,带给你不一样的浏览体验。

软件优势1、轻松搜索,方便快捷,欢迎下载素材浏览app使用。

2、新内核为所有素材浏览器应用用户带来极速上网体验。

3、支持隐身浏览,让您的资料在使用素材浏览器应用时更安全。 查看全部

网页视频抓取浏览器(素材浏览器破解版app是一款非常实用的网页素材抓取工具)

素材浏览器破解版app是一款非常实用的网页素材抓取工具。其功能非常强大,内容非常丰富,深受广大用户的青睐!它有各种风格的素材内容,图片,视频,文章等等!用户可以在这里随意下载,非常方便!该软件的使用方法非常简单,您只需在此处打开各种URL内容,即可自动找到您需要的图片和文件内容,下载供您使用。素材浏览器破解版也是一款快速浏览器,帮助用户快速上网。它没有任何插件,体积很小。过滤所有广告内容,支持外网访问,无需登录即可使用。感兴趣的用户朋友快来下载使用吧!

软件特色1、素材浏览器破解版app支持一键下载和保存网页中的视频、图片、音频、文案等素材。

2、界面简洁,纯浏览,无广告无推广,观看舒适。

3、极速搜索引擎,提供高速上网体验,系统为您推荐相关词条。

4、轻松搜索,方便快捷,支持隐身浏览,使用时信息更安全。

软件功能1、智能搜索:无需手动输入,素材浏览器APP自动识别搜索链接,精彩网页瞬间呈现。

2、 海量素材:素材浏览器APP支持多平台素材搜索,高清原图、视频,免费下载。

3、音频提取:素材浏览器app可以从各种视频中提取音频,一键保存到手机中。

4、下载管理:素材浏览器APP支持批量保存网页图片、视频、音频、文案。软件亮点1、保存速度:拦截无效信息,节省大量流量;提供无图阅读模式,在流量受限时轻松浏览网页;

2、快速启动:素材浏览器破解版app启动快如闪电,退出后台无残留,安全浏览器就是安全浏览器;

3、简约设计:安全浏览器设计简洁舒适,页面清新干净,带给你不一样的浏览体验。

软件优势1、轻松搜索,方便快捷,欢迎下载素材浏览app使用。

2、新内核为所有素材浏览器应用用户带来极速上网体验。

3、支持隐身浏览,让您的资料在使用素材浏览器应用时更安全。

网页视频抓取浏览器(π浏览器app是一款全新推出的极简的手机浏览器工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2022-01-10 02:13

π浏览器app是一款全新的极简手机浏览器工具π浏览器是一款极简浏览器,也可以通过内置播放器直接提取或播放网页视频,当你浏览网页时会自动为你截取,不会后台进程驻留。

最新版π浏览器特点

- 网络视频播放:支持0.75~3倍速、投屏、下载

- 广告过滤:内置超级网页广告过滤规则

- 终极搜索:多搜索引擎支持,自定义搜索引擎

- 隐私保护:拦截自动跳转、拦截恶意下载

- 极其简单快捷:即时启动,无信息流,纯首页

- 工具箱:隐身模式、阅读模式、网页翻译、页内搜索

【内容丰富】:基于大数据算法,兴趣匹配、采集优质新闻、量身定制阅读、追踪新闻热点更便捷。

【极速启动】:闪电般的启动速度,退出后台无残留,浏览器无忧选择安全浏览器。

【实用性强】:支持主流搜索引擎,搜索速度更快。

【简约设计】:安全浏览器设计,简洁舒适,页面清新干净,2265带给你不一样的浏览体验。

v1.2.0 版本

3. 新版浏览器内核,网页加载速度更快

2. 支持自定义首页壁纸,长按首页空白处自由设置壁纸

4. 网络视频播放器支持拉伸、全屏缩放

1. 增强隐私保护功能,支持敏感网页权限管理

π浏览器应用——极速浏览器,内置强大的搜索引擎,上网流畅,快速浏览你要找的资源,支持视频直接下载,网页浏览速度更快,给你带来全新的上网体验,本次浏览浏览器有过滤广告,喜欢就快来下载体验吧!

π浏览器APP是一款全新的极简手机浏览器工具,支持多引擎无广告快速搜索,给你更流畅的浏览体验。π浏览器APP支持各种速度浏览网页,也可以直接下载视频。浏览网页超级方便,给你全新的上网体验。朋友们,你不应该错过它。

π浏览器软件优势

简单快速:简单、省电、省流、无后台进程驻留、极速

智能搜索:智能提示,智能补全,搜索热词,输入网址,搜索极速

全屏阅读:轻轻上推进入全屏,下拉呼出搜索框进行搜索,最便捷的全屏阅读体验。

稍后阅读,离线功能,无网络不怕,最贴心的阅读体验。

Pi 浏览器 Pi 浏览器应用程序功能和大小

功能:超强大的手机浏览器工具,极致搜索,过滤广告,高速浏览,推荐资讯,快来体验吧!

尺寸:50.56m

π浏览器π浏览器应用介绍

π浏览器app是一款非常简单流畅的手机浏览器工具,专业的隐私保护,隐身浏览,非常高效,快来体验吧!

π 浏览器 π 浏览器应用亮点

【简约设计】:安全的浏览器设计,简洁舒适,页面清新干净,给您带来不一样的浏览体验。

【内容丰富】:基于大数据算法,兴趣匹配、采集优质新闻、量身定制阅读、追踪新闻热点更便捷。

【实用性强】:支持主流搜索引擎,搜索速度更快。

【极速启动】:闪电般的启动速度,退出后台无残留,浏览器无忧选择安全浏览器。

Pi 浏览器 Pi 浏览器应用评论

π浏览器app是一款功能非常强大的浏览器工具,极简,极速,给你最流畅的浏览体验。 查看全部

网页视频抓取浏览器(π浏览器app是一款全新推出的极简的手机浏览器工具)

π浏览器app是一款全新的极简手机浏览器工具π浏览器是一款极简浏览器,也可以通过内置播放器直接提取或播放网页视频,当你浏览网页时会自动为你截取,不会后台进程驻留。

最新版π浏览器特点

- 网络视频播放:支持0.75~3倍速、投屏、下载

- 广告过滤:内置超级网页广告过滤规则

- 终极搜索:多搜索引擎支持,自定义搜索引擎

- 隐私保护:拦截自动跳转、拦截恶意下载

- 极其简单快捷:即时启动,无信息流,纯首页

- 工具箱:隐身模式、阅读模式、网页翻译、页内搜索

【内容丰富】:基于大数据算法,兴趣匹配、采集优质新闻、量身定制阅读、追踪新闻热点更便捷。

【极速启动】:闪电般的启动速度,退出后台无残留,浏览器无忧选择安全浏览器。

【实用性强】:支持主流搜索引擎,搜索速度更快。

【简约设计】:安全浏览器设计,简洁舒适,页面清新干净,2265带给你不一样的浏览体验。

v1.2.0 版本

3. 新版浏览器内核,网页加载速度更快

2. 支持自定义首页壁纸,长按首页空白处自由设置壁纸

4. 网络视频播放器支持拉伸、全屏缩放

1. 增强隐私保护功能,支持敏感网页权限管理

π浏览器应用——极速浏览器,内置强大的搜索引擎,上网流畅,快速浏览你要找的资源,支持视频直接下载,网页浏览速度更快,给你带来全新的上网体验,本次浏览浏览器有过滤广告,喜欢就快来下载体验吧!

π浏览器APP是一款全新的极简手机浏览器工具,支持多引擎无广告快速搜索,给你更流畅的浏览体验。π浏览器APP支持各种速度浏览网页,也可以直接下载视频。浏览网页超级方便,给你全新的上网体验。朋友们,你不应该错过它。

π浏览器软件优势

简单快速:简单、省电、省流、无后台进程驻留、极速

智能搜索:智能提示,智能补全,搜索热词,输入网址,搜索极速

全屏阅读:轻轻上推进入全屏,下拉呼出搜索框进行搜索,最便捷的全屏阅读体验。

稍后阅读,离线功能,无网络不怕,最贴心的阅读体验。

Pi 浏览器 Pi 浏览器应用程序功能和大小

功能:超强大的手机浏览器工具,极致搜索,过滤广告,高速浏览,推荐资讯,快来体验吧!

尺寸:50.56m

π浏览器π浏览器应用介绍

π浏览器app是一款非常简单流畅的手机浏览器工具,专业的隐私保护,隐身浏览,非常高效,快来体验吧!

π 浏览器 π 浏览器应用亮点

【简约设计】:安全的浏览器设计,简洁舒适,页面清新干净,给您带来不一样的浏览体验。

【内容丰富】:基于大数据算法,兴趣匹配、采集优质新闻、量身定制阅读、追踪新闻热点更便捷。

【实用性强】:支持主流搜索引擎,搜索速度更快。

【极速启动】:闪电般的启动速度,退出后台无残留,浏览器无忧选择安全浏览器。

Pi 浏览器 Pi 浏览器应用评论

π浏览器app是一款功能非常强大的浏览器工具,极简,极速,给你最流畅的浏览体验。

网页视频抓取浏览器(跨境浏览器3.隔离网络和IP网络的关联因素有哪些?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-04-16 07:17

对于跨境电商来说,无论是亚马逊还是eBay还是Shopee。国内IP有时候很不方便,因为这些跨境平台对商家的政策非常严格。如果找到具有相同IP地址的商店,则将其关联并锁定。

这时,我们就需要一款能够提供有效、稳定、不同IP地址进行反关联的软件。

很久以前,我们用过各种云服务器,但是这些服务器都是在网络上标明的,亚马逊的反关联机制也能抓到。

跨境浏览器

所以为了账户安全,我们放弃了云服务器。并着手寻找更好的反关联工具。

对于网络IP地址的情况,我们选择跨境浏览器进行反关联测试。

经过测试,我得出以下结论。

1. 隔离账户之间的网络和IP

网络和IP之间的关系是一个众所周知的相关因素。电脑硬盘、网卡、路由器等都可能是判断账户关系的依据。指纹浏览器可以实现隔离网络的功能,简化你的账号和IP地址,从而在IP地址上实现一账号一IP的网络环境。

私下浏览

用户的使用习惯信息是亚马逊机器区分关联账户的重要信息。就是通过一个人的浏览习惯来判断每个账号是否由同一个人操作。指纹浏览器可配置独立指纹。这可以防止它被机器识别。

跨境浏览器

3. 模拟生态环境

当我们管理多个账户时,很容易忽视互联网环境的变化。如果我们疏忽,我们可能会登录到同一网络环境中的其他帐户。这种在同一环境下频繁更换账号的行为显然是很容易造成的。后台关注。

因此,防关联浏览器可以配置独立的IP,模拟相应的网络环境,增加防关联的安全性。相当不错! 查看全部

网页视频抓取浏览器(跨境浏览器3.隔离网络和IP网络的关联因素有哪些?)

对于跨境电商来说,无论是亚马逊还是eBay还是Shopee。国内IP有时候很不方便,因为这些跨境平台对商家的政策非常严格。如果找到具有相同IP地址的商店,则将其关联并锁定。

这时,我们就需要一款能够提供有效、稳定、不同IP地址进行反关联的软件。

很久以前,我们用过各种云服务器,但是这些服务器都是在网络上标明的,亚马逊的反关联机制也能抓到。

跨境浏览器

所以为了账户安全,我们放弃了云服务器。并着手寻找更好的反关联工具。

对于网络IP地址的情况,我们选择跨境浏览器进行反关联测试。

经过测试,我得出以下结论。

1. 隔离账户之间的网络和IP

网络和IP之间的关系是一个众所周知的相关因素。电脑硬盘、网卡、路由器等都可能是判断账户关系的依据。指纹浏览器可以实现隔离网络的功能,简化你的账号和IP地址,从而在IP地址上实现一账号一IP的网络环境。

私下浏览

用户的使用习惯信息是亚马逊机器区分关联账户的重要信息。就是通过一个人的浏览习惯来判断每个账号是否由同一个人操作。指纹浏览器可配置独立指纹。这可以防止它被机器识别。

跨境浏览器

3. 模拟生态环境

当我们管理多个账户时,很容易忽视互联网环境的变化。如果我们疏忽,我们可能会登录到同一网络环境中的其他帐户。这种在同一环境下频繁更换账号的行为显然是很容易造成的。后台关注。

因此,防关联浏览器可以配置独立的IP,模拟相应的网络环境,增加防关联的安全性。相当不错!

网页视频抓取浏览器(网页视频抓取浏览器分析工具提取app安装包上传appstore)

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-04-14 16:04

网页视频抓取浏览器分析工具提取app安装包上传appstore网页图片抓取用网页视频抓取工具提取网页视频分析,解析,工具抓取自己手机的app,自己可以写后台,然后可以将分析后的数据上传appstore网页抓取,可以用beef,pagequant分析appstore图片,工具videolapi编程,可以自己写插件,工具freecodecamp网页截图工具自动抓取网页里的图片,工具:,工具:photomerge。

你首先要有网页。最便捷的方法就是弄个能随时请求网站服务的浏览器。不知道这两个网站实例有没有很简单,反正我用了chrome挺好用的。

抓取方法很多,最简单的是使用autorespider,专业的话要看你的目标网站有多复杂的接口,抓取工具也有很多,比如广告联盟工具厂商开发的canweb,对于一些简单的网站效果还不错。有了网站之后,推荐你使用百度的开放平台的抓取插件(exchangedviewer)。

谷歌autorespider,

试试你。

我看有人说page123。这个真的做不到啊,可以考虑一下beef。

安利个效率神器:yicat!

没有合适的工具抓取到主页,后续分析需要一定功力。对于做aso优化的人来说,除了主流广告联盟,还可以通过第三方工具看看竞品app的历史广告展示监控、点击图片地址、重定向的代码等数据,整理出来后使用。 查看全部

网页视频抓取浏览器(网页视频抓取浏览器分析工具提取app安装包上传appstore)

网页视频抓取浏览器分析工具提取app安装包上传appstore网页图片抓取用网页视频抓取工具提取网页视频分析,解析,工具抓取自己手机的app,自己可以写后台,然后可以将分析后的数据上传appstore网页抓取,可以用beef,pagequant分析appstore图片,工具videolapi编程,可以自己写插件,工具freecodecamp网页截图工具自动抓取网页里的图片,工具:,工具:photomerge。

你首先要有网页。最便捷的方法就是弄个能随时请求网站服务的浏览器。不知道这两个网站实例有没有很简单,反正我用了chrome挺好用的。

抓取方法很多,最简单的是使用autorespider,专业的话要看你的目标网站有多复杂的接口,抓取工具也有很多,比如广告联盟工具厂商开发的canweb,对于一些简单的网站效果还不错。有了网站之后,推荐你使用百度的开放平台的抓取插件(exchangedviewer)。

谷歌autorespider,

试试你。

我看有人说page123。这个真的做不到啊,可以考虑一下beef。

安利个效率神器:yicat!

没有合适的工具抓取到主页,后续分析需要一定功力。对于做aso优化的人来说,除了主流广告联盟,还可以通过第三方工具看看竞品app的历史广告展示监控、点击图片地址、重定向的代码等数据,整理出来后使用。

网页视频抓取浏览器(网页视频抓取浏览器、h5、js网页标签都是什么呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-03-30 04:03

网页视频抓取浏览器、h5、js网页标签都是什么呢?你会不会被怎么会这么麻烦呢?虽然标签有许多,但是每一个标签都有相对应的作用。概念篇字体类型background、css3、text、font、box、block等background-disable属性background-color属性background-size属性background-repeat属性1.background-disablecss3background-repeat如果不设置background-repeat属性,则默认关闭文档中所有元素的background对象中的background属性。

如果允许你background-repeat设置它,则元素中的background-repeat对象将开启元素的background-repeat属性。如果任何其他元素创建一个background-repeat对象,则元素将开启snapshot-background属性。要检查元素中是否是使用snapshot-background-color设置元素的背景颜色,请检查元素中是否允许background-repeat设置exported。

2.background-colorcss3和standard都提供了background-color属性可供给浏览器或操作系统的底层以及浏览器内核使用。例如可以根据默认的background-color设置默认的background-repeat属性,或者默认的background-repeat设置background-color属性,包括:background-color:none(undercurrentcolor),undercurrentcolor(pre-renderedcolor),0(fullcolor),justify-content(0,100%),repeat-references(referencesoftheexportedbackground),point-aliasing(pointcolorforreferencesoftheexportedbackground),space-align-items(spacealignaxis)。

3.textborderborder-style属性是否允许monospace属性--css规范中关于text-border-style和monospace有明确的规定-text-border-style属性也许会有很多值,不过建议按照一些值设置,例如width和height,具体说如text-border-style-twonf和text-border-twoae等。

相信,有很多同学都曾阅读过这样的文章。实践篇看看不一样的网页视频抓取你在视频抓取的过程中,通常会遇到视频的采集、压缩、裁剪、水印等一系列的环节。首先,你将获取并解压视频文件://采集视频文件varwithinvideo=(function(parameters){//设置request方法的参数parameters.preload=function(cls){//抛弃srcset队列中的元素,解包后返回所有srcset对象}})({...});接下来,你将将采集网站上所有的视频://获取网站上所有的视频functiongetrootplayer(parameters){//设置hash属性parameters.requestversion="20190318";//返回所有的视频文件列表hash=getroot_templ。 查看全部

网页视频抓取浏览器(网页视频抓取浏览器、h5、js网页标签都是什么呢?)

网页视频抓取浏览器、h5、js网页标签都是什么呢?你会不会被怎么会这么麻烦呢?虽然标签有许多,但是每一个标签都有相对应的作用。概念篇字体类型background、css3、text、font、box、block等background-disable属性background-color属性background-size属性background-repeat属性1.background-disablecss3background-repeat如果不设置background-repeat属性,则默认关闭文档中所有元素的background对象中的background属性。

如果允许你background-repeat设置它,则元素中的background-repeat对象将开启元素的background-repeat属性。如果任何其他元素创建一个background-repeat对象,则元素将开启snapshot-background属性。要检查元素中是否是使用snapshot-background-color设置元素的背景颜色,请检查元素中是否允许background-repeat设置exported。

2.background-colorcss3和standard都提供了background-color属性可供给浏览器或操作系统的底层以及浏览器内核使用。例如可以根据默认的background-color设置默认的background-repeat属性,或者默认的background-repeat设置background-color属性,包括:background-color:none(undercurrentcolor),undercurrentcolor(pre-renderedcolor),0(fullcolor),justify-content(0,100%),repeat-references(referencesoftheexportedbackground),point-aliasing(pointcolorforreferencesoftheexportedbackground),space-align-items(spacealignaxis)。

3.textborderborder-style属性是否允许monospace属性--css规范中关于text-border-style和monospace有明确的规定-text-border-style属性也许会有很多值,不过建议按照一些值设置,例如width和height,具体说如text-border-style-twonf和text-border-twoae等。

相信,有很多同学都曾阅读过这样的文章。实践篇看看不一样的网页视频抓取你在视频抓取的过程中,通常会遇到视频的采集、压缩、裁剪、水印等一系列的环节。首先,你将获取并解压视频文件://采集视频文件varwithinvideo=(function(parameters){//设置request方法的参数parameters.preload=function(cls){//抛弃srcset队列中的元素,解包后返回所有srcset对象}})({...});接下来,你将将采集网站上所有的视频://获取网站上所有的视频functiongetrootplayer(parameters){//设置hash属性parameters.requestversion="20190318";//返回所有的视频文件列表hash=getroot_templ。

网页视频抓取浏览器(VideoCacheView能让您很容易地复制缓存的视频文件或以便将来观看)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-03-28 05:05

当您在某个 网站 上观看完视频后,您可能希望保存该视频文件以供将来离线播放。如果视频文件存储在浏览器的缓存中,VideoCacheView 可以帮助您从缓存中提取视频文件并保存以供将来查看。

指示

VideoCacheView 自动扫描 Internet Explorer 和基于 Mozilla 的 Web 浏览器(包括 FireFox)的整个缓存,以查找当前存储在其中的所有视频文件。它允许您轻松复制缓存的视频文件或其他目录以供将来播放和查看。如果您有与 FLV 文件关联的视频播放器,您也可以直接从缓存中播放视频文件。

指示

VideoCacheView是一款绿色软件,无需安装或附加DLL链接库,只需执行VideoCacheView.exe文件即可。运行 VideoCacheView 后,它会自动扫描您的 IE 或 Mozilla 浏览器的缓存目录,等待 5-30 秒扫描完成后,程序主窗口将显示缓存中的所有视频文件。

主窗口中的视频文件列表显示后,根据视频文件是否保存在本地缓存中,您可以选择以下不同的操作选项:

如果缓存中存在视频文件,可选择“播放所选文件”、“将所选文件复制到”等操作;

如果缓存中不存在视频文件,可以选择“在浏览器中打开下载地址”、“复制下载地址”等操作。 查看全部

网页视频抓取浏览器(VideoCacheView能让您很容易地复制缓存的视频文件或以便将来观看)

当您在某个 网站 上观看完视频后,您可能希望保存该视频文件以供将来离线播放。如果视频文件存储在浏览器的缓存中,VideoCacheView 可以帮助您从缓存中提取视频文件并保存以供将来查看。

指示

VideoCacheView 自动扫描 Internet Explorer 和基于 Mozilla 的 Web 浏览器(包括 FireFox)的整个缓存,以查找当前存储在其中的所有视频文件。它允许您轻松复制缓存的视频文件或其他目录以供将来播放和查看。如果您有与 FLV 文件关联的视频播放器,您也可以直接从缓存中播放视频文件。

指示

VideoCacheView是一款绿色软件,无需安装或附加DLL链接库,只需执行VideoCacheView.exe文件即可。运行 VideoCacheView 后,它会自动扫描您的 IE 或 Mozilla 浏览器的缓存目录,等待 5-30 秒扫描完成后,程序主窗口将显示缓存中的所有视频文件。

主窗口中的视频文件列表显示后,根据视频文件是否保存在本地缓存中,您可以选择以下不同的操作选项:

如果缓存中存在视频文件,可选择“播放所选文件”、“将所选文件复制到”等操作;

如果缓存中不存在视频文件,可以选择“在浏览器中打开下载地址”、“复制下载地址”等操作。

网页视频抓取浏览器(哪些网页才是重要性高的呢?如何量化重要性呢?(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 48 次浏览 • 2022-03-20 06:28

)

相关话题

网页抓取优先策略

18/1/2008 11:30:00

网络爬取优先策略,也称为“页面选择”(pageSelection),通常是尽可能先爬取重要的网页,以保证在有限的资源范围内,尽可能多的照顾到那些重要的页面。那么哪些页面最重要?如何量化重要性?

搜索引擎如何抓取网页?

22/11/2011 09:50:00

搜索引擎在抓取大量原创网页时,会进行预处理,主要包括四个方面,关键词的提取,“镜像网页”(网页内容完全一致)未经任何修改)或“转载网页”。”(近似复制,主题内容基本相同但可能有一些额外的编辑信息等,转载的网页也称为“近似镜像网页”)消除,链接分析和网页重要性的计算。

原压力反馈工具改名,增加抓取频率。增加了闭站保护功能。

29/5/2014 11:42:00

日前,百度站长平台发布公告称,原压力反馈工具已更名为“爬频”。如果百度蜘蛛的爬取影响了网站的稳定性,站长可以每天使用“爬频”工具调整百度蜘蛛。访问网站的频率;以及新增的闭站保护功能 在闭站保护过程中,收录之前的所有页面都会受到保护,不会作为死链接被清理。

将视频融入网页设计有什么好处?

15/9/2017 14:34:00

随着网络传输速度的提高,视频在网页中的应用越来越广泛,网络视频的带宽和流量限制已不再像五年前那样明显。

将视频融入网页设计有什么好处?

15/9/2017 14:34:00

随着网络传输速度的提高,视频在网页中的应用越来越广泛,网络视频的带宽和流量限制已不再像五年前那样明显。

翻页式网络搜索引擎如何抓取

2013 年 7 月 11 日 10:53:00

Spider 系统的目标是发现和爬取 Internet 上所有有价值的网页。百度官方也明确表示,蜘蛛只能抓取尽可能多的有价值资源,并保持系统中页面与实际环境的一致性。@网站经验造成压力,也就是说蜘蛛不会爬取网站的所有页面。蜘蛛的爬取策略有很多,可以尽可能快速完整的找到资源链接,提高爬取效率。

什么是标签页?如何优化标签页?

27/4/202010:57:11

什么是标签页?如何优化标签页?标签页是很常用的,如果用得好,SEO效果会很好,但是很多网站标签页使用不当,甚至可能产生负面影响,所以这是一个很好的问题。但是这个问题

Google 适当地将 POST 请求添加到 GET 以抓取网页内容

15/12/2011 13:58:00

近日,Google Blackboard 发布了一篇题为“GET、POST 和安全地获取更多在线信息”的博文。文章详细说明 Google 最近对抓取网页内容的方式所做的改进。文章 中提到,Google 以后在读取网页内容时,不仅会使用 GET 抓取,还会视情况增加 POST 请求方式来抓取网页内容,进一步提升 Google 搜索引擎抓取网页内容的能力。网页的内容。网页内容的判断。

如何系统地做好SEO-web抓取

14/5/202014:41:34

没有爬取就没有页面的收录。如何获取或改进搜索引擎的爬取?

详细讲解php爬取网页内容的例子

6/8/202018:02:42

php爬取网页内容示例详解方法一:使用file_get_contents方法实现$url="";$html=file_ge

如何解决php网页抓取出现乱码问题

2012 年 4 月 9 日:03:36

php网页抓取乱码的解决方法:1、使用“mbconvertencoding”转换编码;2、添加“curl_setopt($ch,CURLOPT_ENCODING,'gzip');” 选项; 3、在顶部添加标题代码。推荐

百度爬网对网页的个数和特殊字符有要求吗?

28/8/2018 10:21:10

Q:我们有一个3000多行中文+英文的网页,截图显示不全。是通过站长平台模拟的(注:这位同学指的是刮痧诊断工具),文字也不全。对于网站影响会很大吗?院长把这个一般性的问题分解成小问题,向工程师确认。第一个问题:百度对网页内容的大小有限制吗?答:内容中文字数量不限,但源码有一定大小

谷歌允许蜘蛛自动填写表单提交以抓取更多页面

2009 年 3 月 31 日 14:54:00

据外媒报道:美国搜索巨头谷歌最近开始在网络爬虫中实施一项新技术:他们可以让蜘蛛在某些网页中自动填写表单,并自动提交给服务器爬取反馈页面,以获取更多信息。关于这个 网站 的详细信息。

通过搜索引擎改进网络爬取、索引和排名的方法

2009 年 7 月 12 日 10:37:00

这是一个被许多 SEO 误解的重要概念。很久以前,搜索引擎爬虫(机器人)会递归地爬取某个网站(通过你提交的网站主页URL,然后爬取页面上找到的所有链接)指向该网页, 一次又一次)。

微信发布4.2版:支持视频通话,增加网页版

19/7/2012 15:11:00

微信正式发布4.第二版安装包。新版微信推出好友视频通话功能,并新增网页版,支持手机与电脑连接。目前微信4.2版本只支持iOS系统。

查看全部

网页视频抓取浏览器(哪些网页才是重要性高的呢?如何量化重要性呢?(组图)

)

相关话题

网页抓取优先策略

18/1/2008 11:30:00

网络爬取优先策略,也称为“页面选择”(pageSelection),通常是尽可能先爬取重要的网页,以保证在有限的资源范围内,尽可能多的照顾到那些重要的页面。那么哪些页面最重要?如何量化重要性?

搜索引擎如何抓取网页?

22/11/2011 09:50:00

搜索引擎在抓取大量原创网页时,会进行预处理,主要包括四个方面,关键词的提取,“镜像网页”(网页内容完全一致)未经任何修改)或“转载网页”。”(近似复制,主题内容基本相同但可能有一些额外的编辑信息等,转载的网页也称为“近似镜像网页”)消除,链接分析和网页重要性的计算。

原压力反馈工具改名,增加抓取频率。增加了闭站保护功能。

29/5/2014 11:42:00

日前,百度站长平台发布公告称,原压力反馈工具已更名为“爬频”。如果百度蜘蛛的爬取影响了网站的稳定性,站长可以每天使用“爬频”工具调整百度蜘蛛。访问网站的频率;以及新增的闭站保护功能 在闭站保护过程中,收录之前的所有页面都会受到保护,不会作为死链接被清理。

将视频融入网页设计有什么好处?

15/9/2017 14:34:00

随着网络传输速度的提高,视频在网页中的应用越来越广泛,网络视频的带宽和流量限制已不再像五年前那样明显。

将视频融入网页设计有什么好处?

15/9/2017 14:34:00

随着网络传输速度的提高,视频在网页中的应用越来越广泛,网络视频的带宽和流量限制已不再像五年前那样明显。

翻页式网络搜索引擎如何抓取

2013 年 7 月 11 日 10:53:00

Spider 系统的目标是发现和爬取 Internet 上所有有价值的网页。百度官方也明确表示,蜘蛛只能抓取尽可能多的有价值资源,并保持系统中页面与实际环境的一致性。@网站经验造成压力,也就是说蜘蛛不会爬取网站的所有页面。蜘蛛的爬取策略有很多,可以尽可能快速完整的找到资源链接,提高爬取效率。

什么是标签页?如何优化标签页?

27/4/202010:57:11

什么是标签页?如何优化标签页?标签页是很常用的,如果用得好,SEO效果会很好,但是很多网站标签页使用不当,甚至可能产生负面影响,所以这是一个很好的问题。但是这个问题

Google 适当地将 POST 请求添加到 GET 以抓取网页内容

15/12/2011 13:58:00

近日,Google Blackboard 发布了一篇题为“GET、POST 和安全地获取更多在线信息”的博文。文章详细说明 Google 最近对抓取网页内容的方式所做的改进。文章 中提到,Google 以后在读取网页内容时,不仅会使用 GET 抓取,还会视情况增加 POST 请求方式来抓取网页内容,进一步提升 Google 搜索引擎抓取网页内容的能力。网页的内容。网页内容的判断。

如何系统地做好SEO-web抓取

14/5/202014:41:34

没有爬取就没有页面的收录。如何获取或改进搜索引擎的爬取?

详细讲解php爬取网页内容的例子

6/8/202018:02:42

php爬取网页内容示例详解方法一:使用file_get_contents方法实现$url="";$html=file_ge

如何解决php网页抓取出现乱码问题

2012 年 4 月 9 日:03:36

php网页抓取乱码的解决方法:1、使用“mbconvertencoding”转换编码;2、添加“curl_setopt($ch,CURLOPT_ENCODING,'gzip');” 选项; 3、在顶部添加标题代码。推荐

百度爬网对网页的个数和特殊字符有要求吗?

28/8/2018 10:21:10

Q:我们有一个3000多行中文+英文的网页,截图显示不全。是通过站长平台模拟的(注:这位同学指的是刮痧诊断工具),文字也不全。对于网站影响会很大吗?院长把这个一般性的问题分解成小问题,向工程师确认。第一个问题:百度对网页内容的大小有限制吗?答:内容中文字数量不限,但源码有一定大小

谷歌允许蜘蛛自动填写表单提交以抓取更多页面

2009 年 3 月 31 日 14:54:00

据外媒报道:美国搜索巨头谷歌最近开始在网络爬虫中实施一项新技术:他们可以让蜘蛛在某些网页中自动填写表单,并自动提交给服务器爬取反馈页面,以获取更多信息。关于这个 网站 的详细信息。

通过搜索引擎改进网络爬取、索引和排名的方法

2009 年 7 月 12 日 10:37:00

这是一个被许多 SEO 误解的重要概念。很久以前,搜索引擎爬虫(机器人)会递归地爬取某个网站(通过你提交的网站主页URL,然后爬取页面上找到的所有链接)指向该网页, 一次又一次)。

微信发布4.2版:支持视频通话,增加网页版

19/7/2012 15:11:00

微信正式发布4.第二版安装包。新版微信推出好友视频通话功能,并新增网页版,支持手机与电脑连接。目前微信4.2版本只支持iOS系统。

网页视频抓取浏览器(素材浏览器破解版app是一款非常实用的网页素材抓取工具)

网站优化 • 优采云 发表了文章 • 0 个评论 • 63 次浏览 • 2022-03-13 23:23

素材浏览器破解版app是一款非常实用的网页素材抓取工具。其功能非常强大,内容非常丰富,深受广大用户的青睐!它有各种风格的素材内容,图片,视频,文章等等!用户可以在这里随意下载,非常方便!该软件的使用方法非常简单,您只需在此处打开各种URL内容,即可自动找到您需要的图片和文件内容,下载供您使用。素材浏览器破解版也是一款快速浏览器,帮助用户快速上网。它没有任何插件,体积很小。过滤所有广告内容,支持外网访问,无需登录即可使用。感兴趣的用户朋友快来下载使用吧!

软件特色1、素材浏览器破解版app支持一键下载和保存网页中的视频、图片、音频、文案等素材。

2、界面简洁,纯浏览,无广告无推广,观看舒适。

3、极速搜索引擎,提供高速上网体验,系统为您推荐相关词条。

4、轻松搜索,方便快捷,支持隐身浏览,使用时信息更安全。

软件功能1、智能搜索:无需手动输入,素材浏览器APP自动识别搜索链接,精彩网页瞬间呈现。

2、 海量素材:素材浏览器APP支持多平台素材搜索,高清原图、视频,免费下载。

3、音频提取:素材浏览器app可以从各种视频中提取音频,一键保存到手机中。

4、下载管理:素材浏览器APP支持批量保存网页图片、视频、音频、文案。软件亮点1、保存速度:拦截无效信息,节省大量流量;提供无图阅读模式,在流量受限时轻松浏览网页;

2、快速启动:素材浏览器破解版app启动快如闪电,退出后台无残留,安全浏览器就是安全浏览器;

3、简约设计:安全浏览器设计简洁舒适,页面清新干净,带给你不一样的浏览体验。

软件优势1、轻松搜索,方便快捷,欢迎下载素材浏览app使用。

2、新内核为所有素材浏览器应用用户带来极速上网体验。

3、支持隐身浏览,让您的资料在使用素材浏览器应用时更安全。 查看全部

网页视频抓取浏览器(素材浏览器破解版app是一款非常实用的网页素材抓取工具)

素材浏览器破解版app是一款非常实用的网页素材抓取工具。其功能非常强大,内容非常丰富,深受广大用户的青睐!它有各种风格的素材内容,图片,视频,文章等等!用户可以在这里随意下载,非常方便!该软件的使用方法非常简单,您只需在此处打开各种URL内容,即可自动找到您需要的图片和文件内容,下载供您使用。素材浏览器破解版也是一款快速浏览器,帮助用户快速上网。它没有任何插件,体积很小。过滤所有广告内容,支持外网访问,无需登录即可使用。感兴趣的用户朋友快来下载使用吧!

软件特色1、素材浏览器破解版app支持一键下载和保存网页中的视频、图片、音频、文案等素材。

2、界面简洁,纯浏览,无广告无推广,观看舒适。

3、极速搜索引擎,提供高速上网体验,系统为您推荐相关词条。

4、轻松搜索,方便快捷,支持隐身浏览,使用时信息更安全。

软件功能1、智能搜索:无需手动输入,素材浏览器APP自动识别搜索链接,精彩网页瞬间呈现。

2、 海量素材:素材浏览器APP支持多平台素材搜索,高清原图、视频,免费下载。

3、音频提取:素材浏览器app可以从各种视频中提取音频,一键保存到手机中。

4、下载管理:素材浏览器APP支持批量保存网页图片、视频、音频、文案。软件亮点1、保存速度:拦截无效信息,节省大量流量;提供无图阅读模式,在流量受限时轻松浏览网页;

2、快速启动:素材浏览器破解版app启动快如闪电,退出后台无残留,安全浏览器就是安全浏览器;

3、简约设计:安全浏览器设计简洁舒适,页面清新干净,带给你不一样的浏览体验。

软件优势1、轻松搜索,方便快捷,欢迎下载素材浏览app使用。

2、新内核为所有素材浏览器应用用户带来极速上网体验。

3、支持隐身浏览,让您的资料在使用素材浏览器应用时更安全。

网页视频抓取浏览器(网页视频抓取浏览器播放页面,可视化多页面爬取大规模)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2022-03-09 05:01

网页视频抓取浏览器播放页面,

可视化多页面爬取

大规模(如aspx小规模可抓取的网页达到1-3万个)用cookie,memcache,

urllib+urllib2+requests+bs4+postman简单的解决几个大问题:异步解决接口异常问题(大部分的接口一般都是异步加载)抓取速度快方便自动化解决工具冲突(java抓包解决所有的问题)简单易用urllib2需要加上相应的http库解决不同的协议问题一般中间有一个链接默认选项是https=requests需要你指定代理。

提供基础的简单的解决方案,一个是请求方法,一个是url处理方法,一个是消息传递方法,一个是解析方法,一个是根据请求去生成model。