网页视频抓取浏览器( 用Jupyter-Notebook并结合框架(Selenium)模拟浏览器微博图片保存本地)

优采云 发布时间: 2022-02-02 19:09网页视频抓取浏览器(

用Jupyter-Notebook并结合框架(Selenium)模拟浏览器微博图片保存本地)

正文 | 潮汐

来源:Python技术《ID:pythonall》

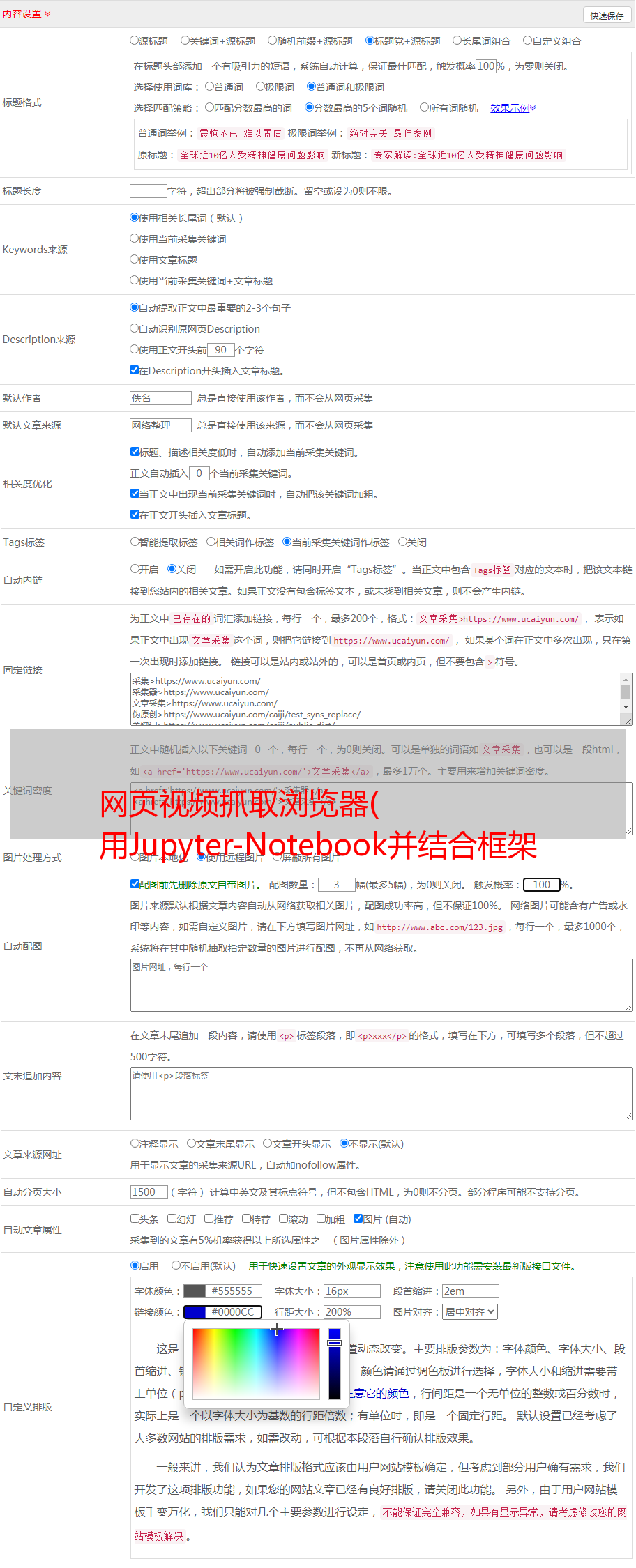

今天我们使用Jupyter-Notebook结合框架(Selenium)来模拟浏览器抓取微博图片并将图片保存到本地。

Selenium是使用计算机模拟人类操作的浏览器网页,可以实现自动化测试,模拟浏览器数据抓取等。

环境部署安装 Jupyter notebook

Jupyter notebook的详细知识在之前的文章中有详细介绍。详细请参考文章文章了解Jupyter notebook

这里只需要在命令行中输入:jupyter notebook即可启动并跳转到浏览器编辑界面。

浏览器页面:

安装硒

安装 Selenium 非常简单,您只需要使用命令“pip install Selenium”。安装成功提示如下:

下载浏览器驱动

下载驱动地址如下:

火狐浏览器驱动

Chrome浏览器驱动:chromedriver

IE浏览器驱动:IEDriverServer

边缘浏览器驱动程序:Microsoft WebDriver

需要将浏览器驱动放入系统路径,或者直接告诉selenuim驱动路径。

环境搭建好之后,就可以直接开始爬取数据了。

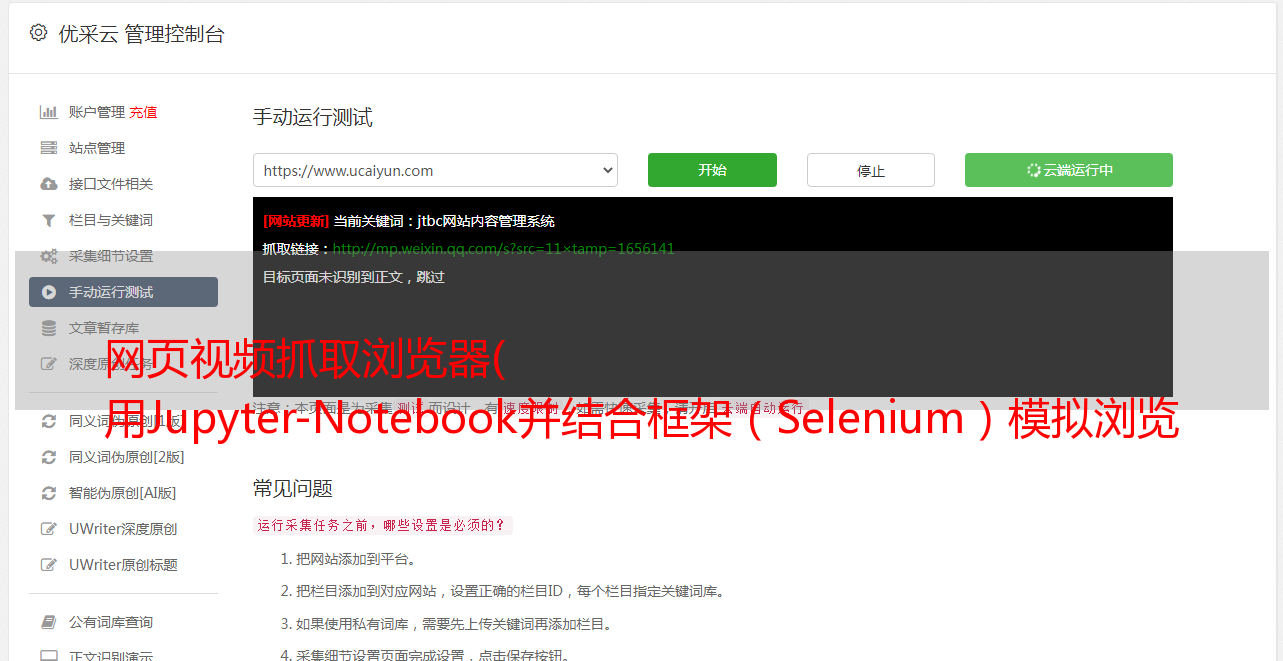

抓取微博数据

首先导入包,模拟浏览器访问微博首页。详细代码如下:

from selenium import webdriver

driver = webdriver.Chrome()

driver.get('https://weibo.com/')

此时,浏览器会打开一个新页面,如下图所示:

接下来开始分析页面数据:在微博页面搜索奥运关键词后会出现一个新页面,然后复制网址,抓取奥运相关图片并保存到本地。搜索界面如下:

输入网址获取页面内容:

driver.get('https://s.weibo.com/weibo/%25E5%25A5%25A5%25E8%25BF%2590%25E4%25BC%259A?topnav=1&wvr=6&b=1')

contents = driver.find_elements_by_xpath(r'//p[@class="txt"]')

print(len(contents))

输出如下:

查看页面详情:

for i in range(0,3):

print("==============================")

print(contents[i].get_attribute('innerHTML'))

获取图片信息:

contents = driver.find_elements_by_xpath(r'//img[@action-type="fl_pics"]')

print(len(contents))

for i in range(0,20):

print("==============================")

print(contents[i].get_attribute('src'))

下载图片到本地:

import os

import urllib.request

for i in range(0,20):

print("==============================")

image_url=contents[i].get_attribute('src')

file_name="downloads//p"+str(i)+".jpg"

print(image_url,file_name)

urllib.request.urlretrieve(image_url, filename=file_name)

至此,微博页面上关于奥运会的相关图片已经保存在本地。图片保存细节如下:

总结代码如下

from selenium import webdriver

import urllib.request

driver = webdriver.Chrome()

driver.get('https://weibo.com/')

driver.get('https://s.weibo.com/weibo/%25E5%25A5%25A5%25E8%25BF%2590%25E4%25BC%259A?topnav=1&wvr=6&b=1')

contents = driver.find_elements_by_xpath(r'//p[@class="txt"]')

for i in range(0,3):

print("==============================")

print(contents[i].get_attribute('innerHTML'))

contents = driver.find_elements_by_xpath(r'//img[@action-type="fl_pics"]')

print(len(contents))

for i in range(0,20):

print("==============================")

print(contents[i].get_attribute('src'))

for i in range(0,20):

print("==============================")

image_url=contents[i].get_attribute('src')

file_name="downloads//p"+str(i)+".jpg"

print(image_url,file_name)

urllib.request.urlretrieve(image_url, filename=file_name)

以上总结代码供没有安装Jupyter Notebook的朋友使用,希望对大家有所帮助。

总结

今天的文章主要讲解使用Jupyter Notebook工具和Selenium框架抓取微博数据,希望对大家有所帮助。