网页新闻抓取

网页新闻抓取(Python案例scrapy抓取学院新闻报告任务抓取公共管理学院官网)

网站优化 • 优采云 发表了文章 • 0 个评论 • 247 次浏览 • 2022-03-29 15:17

蟒蛇案例

scrapy 抓取大学新闻报道

任务

从四川大学公共管理学院官方网站获取所有新闻和查询。

实验过程

1.确定获取目标。

2.创建抓取规则。

3.编写/调试抓取规则。

4.获取爬取数据

1.识别爬取目标

这次我们要抢的目标是四川大学公共管理学院的所有新闻资讯。所以我们需要知道公共管理学院官网的布局。

在这里我们发现,如果要抓取所有新闻信息,不能直接在官网首页抓取,需要点击“更多”进入综合新闻版块。

我们看到了具体的新闻板块,但这显然不能满足我们的抓取需求:目前的新闻动态网页只能抓取新闻的时间、标题和网址,而不能抓取新闻的内容。所以我们要进入新闻详情页面去抓取新闻的具体内容。

2.创建抓取规则

通过第一部分的分析,我们会认为如果要抓取一条新闻的具体信息,需要从新闻动态页面点击进入新闻详情页面,抓取新闻的具体内容。让我们点击新闻试试

我们发现可以直接在新闻详情页抓取我们需要的数据:标题、时间、内容.URL。

好了,现在我们对抢一条新闻有了清晰的认识。但是如何抓取所有的新闻内容呢?

这对我们来说显然并不难。

我们可以在新闻部分的底部看到页面跳转按钮。然后我们可以通过“下一页”按钮抓取所有新闻。

所以整理思路后,我们可以想到一个明显的抓取规则:

通过抓取新闻版块下的所有新闻链接,进入新闻详情链接即可抓取所有新闻内容。

3.编写/调试抓取规则

为了让调试爬虫的粒度尽可能小,我把编写和调试模块组合在一起。

在爬虫中,我将实现以下功能点:

1.从新闻版块下的所有新闻链接中爬出一页

2.通过一个页面上爬取的新闻链接,进入新闻详情,爬取需要的数据(主要是新闻内容)

3.通过循环抓取所有新闻。

对应的知识点为:

1.爬出一个页面下的基础数据。

2.对爬取的数据进行二次爬取。

3.通过循环爬取网页的所有数据。

事不宜迟,我们现在就开始吧。

3.1 爬出页面新闻版块下的所有新闻链接

通过对新闻栏目源码的分析,我们发现抓取到的数据结构如下:

那么我们只需要将爬虫的选择器定位到(li:newsinfo_box_cf),然后执行for循环即可抓取。

编写代码

import scrapyclass News2Spider(scrapy.Spider):

测试并通过!

3.2 通过页面上爬取的新闻链接输入爬取新闻详情(主要是新闻内容)所需的数据

现在我已经获取了一组网址,现在我需要输入每个网址来抓取我需要的标题、时间和内容。代码实现也很简单,只需要在原代码抓取网址时输入网址,抓取到对应的数据即可。所以,我只需要再写一个grab方法进入新闻详情页面,并使用scapy.request调用即可。

编写代码

#进入新闻详情页的抓取方法def parse_dir_contents(self, response): item = GgglxyItem() item[date] = response.xpath("//div[@class=detail_zy_title]/p/text()").extract_first() item[href] = response item[title] = response.xpath("//div[@class=detail_zy_title]/h1/text()").extract_first()

整合到原代码中后,有:

import scrapyfrom ggglxy.items import GgglxyItemclass News2Spider(scrapy.Spider):

测试并通过!

然后我们添加一个循环:

NEXT_PAGE_NUM = 1 NEXT_PAGE_NUM = NEXT_PAGE_NUM + 1

添加到原创代码中:

import scrapyfrom ggglxy.items import GgglxyItem

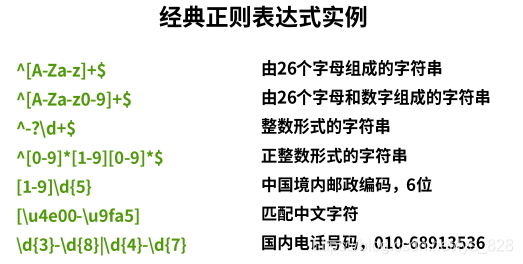

测试:

Paste_Image.png

捕获的数量是191,但我们在官网上找到了193条新闻,少了两条。

为什么?我们注意到日志中有两个错误:

定位问题:原来学院新闻栏目有两个隐藏的二级栏目:

例如:

Paste_Image.png

对应的网址是

Paste_Image.png

网址都不一样,难怪抓不到!

那么我们要对这两个二级列的url设置特殊的规则,只需要添加判断是否是二级列:

if URL.find(type) != -1: yield scrapy.Request(URL, callback=self.parse)

组装原函数:

import scrapy

测试:

4.获取爬取数据

scrapy crawl news_info_2 -o 0016.json

如果您在学习过程中遇到任何问题或想获取学习资源,欢迎加入学习交流群

626062078,一起学Python吧! 查看全部

网页新闻抓取(Python案例scrapy抓取学院新闻报告任务抓取公共管理学院官网)

蟒蛇案例

scrapy 抓取大学新闻报道

任务

从四川大学公共管理学院官方网站获取所有新闻和查询。

实验过程

1.确定获取目标。

2.创建抓取规则。

3.编写/调试抓取规则。

4.获取爬取数据

1.识别爬取目标

这次我们要抢的目标是四川大学公共管理学院的所有新闻资讯。所以我们需要知道公共管理学院官网的布局。

在这里我们发现,如果要抓取所有新闻信息,不能直接在官网首页抓取,需要点击“更多”进入综合新闻版块。

我们看到了具体的新闻板块,但这显然不能满足我们的抓取需求:目前的新闻动态网页只能抓取新闻的时间、标题和网址,而不能抓取新闻的内容。所以我们要进入新闻详情页面去抓取新闻的具体内容。

2.创建抓取规则

通过第一部分的分析,我们会认为如果要抓取一条新闻的具体信息,需要从新闻动态页面点击进入新闻详情页面,抓取新闻的具体内容。让我们点击新闻试试

我们发现可以直接在新闻详情页抓取我们需要的数据:标题、时间、内容.URL。

好了,现在我们对抢一条新闻有了清晰的认识。但是如何抓取所有的新闻内容呢?

这对我们来说显然并不难。

我们可以在新闻部分的底部看到页面跳转按钮。然后我们可以通过“下一页”按钮抓取所有新闻。

所以整理思路后,我们可以想到一个明显的抓取规则:

通过抓取新闻版块下的所有新闻链接,进入新闻详情链接即可抓取所有新闻内容。

3.编写/调试抓取规则

为了让调试爬虫的粒度尽可能小,我把编写和调试模块组合在一起。

在爬虫中,我将实现以下功能点:

1.从新闻版块下的所有新闻链接中爬出一页

2.通过一个页面上爬取的新闻链接,进入新闻详情,爬取需要的数据(主要是新闻内容)

3.通过循环抓取所有新闻。

对应的知识点为:

1.爬出一个页面下的基础数据。

2.对爬取的数据进行二次爬取。

3.通过循环爬取网页的所有数据。

事不宜迟,我们现在就开始吧。

3.1 爬出页面新闻版块下的所有新闻链接

通过对新闻栏目源码的分析,我们发现抓取到的数据结构如下:

那么我们只需要将爬虫的选择器定位到(li:newsinfo_box_cf),然后执行for循环即可抓取。

编写代码

import scrapyclass News2Spider(scrapy.Spider):

测试并通过!

3.2 通过页面上爬取的新闻链接输入爬取新闻详情(主要是新闻内容)所需的数据

现在我已经获取了一组网址,现在我需要输入每个网址来抓取我需要的标题、时间和内容。代码实现也很简单,只需要在原代码抓取网址时输入网址,抓取到对应的数据即可。所以,我只需要再写一个grab方法进入新闻详情页面,并使用scapy.request调用即可。

编写代码

#进入新闻详情页的抓取方法def parse_dir_contents(self, response): item = GgglxyItem() item[date] = response.xpath("//div[@class=detail_zy_title]/p/text()").extract_first() item[href] = response item[title] = response.xpath("//div[@class=detail_zy_title]/h1/text()").extract_first()

整合到原代码中后,有:

import scrapyfrom ggglxy.items import GgglxyItemclass News2Spider(scrapy.Spider):

测试并通过!

然后我们添加一个循环:

NEXT_PAGE_NUM = 1 NEXT_PAGE_NUM = NEXT_PAGE_NUM + 1

添加到原创代码中:

import scrapyfrom ggglxy.items import GgglxyItem

测试:

Paste_Image.png

捕获的数量是191,但我们在官网上找到了193条新闻,少了两条。

为什么?我们注意到日志中有两个错误:

定位问题:原来学院新闻栏目有两个隐藏的二级栏目:

例如:

Paste_Image.png

对应的网址是

Paste_Image.png

网址都不一样,难怪抓不到!

那么我们要对这两个二级列的url设置特殊的规则,只需要添加判断是否是二级列:

if URL.find(type) != -1: yield scrapy.Request(URL, callback=self.parse)

组装原函数:

import scrapy

测试:

4.获取爬取数据

scrapy crawl news_info_2 -o 0016.json

如果您在学习过程中遇到任何问题或想获取学习资源,欢迎加入学习交流群

626062078,一起学Python吧!

网页新闻抓取(Python代码的适用实例有哪些?WebScraping的基本原理步骤)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-03-29 15:17

本文主要介绍Web Scraping的基本原理,基于Python语言,白话,面向可爱小白(^-^)。

令人困惑的名字:

很多时候,人们会将网上获取数据的代码称为“爬虫”。

但其实所谓的“爬虫”并不是特别准确,因为“爬虫”也是分类的,

有两种常见的“爬行动物”:

网络爬虫,也称为蜘蛛;Spiderbot Web Scraper,也称为 Web Harvesting;网络数据提取

不过,这文章主要说明了第二种“网络爬虫”的原理。

什么是网页抓取?

简单地说,Web Scraping,(在本文中)是指使用 Python 代码从肉眼可见的网页中抓取数据。

为什么需要网页抓取?

因为,重复太多的工作,自己做,可能会很累!

有哪些适用的代码示例?例如,您需要下载证券交易所 50 种不同股票的当前价格,或者,您想打印出新闻 网站 上所有最新新闻的头条新闻,或者,只是想把网站上的所有商品,列出价格,放到Excel中对比,等等,尽情发挥你的想象力吧……

Web Scraping的基本原理:

首先,您需要了解网页是如何在我们的屏幕上呈现的;

其实我们发送一个Request,然后100公里外的服务器给我们返回一个Response;然后我们看了很多文字,最后,浏览器偷偷把文字排版,放到我们的屏幕上;更详细的原理可以看我之前的博文HTTP下午茶-小白简介

然后,我们需要了解如何使用 Python 来实现它。实现原理基本上有四个步骤:

首先,代码需要向服务器发送一个Request,然后接收一个Response(html文件)。然后,我们需要对接收到的 Response 进行处理,找到我们需要的文本。然后,我们需要设计代码流来处理重复性任务。最后,导出我们得到的数据,最好在摘要末尾的一个漂亮的 Excel 电子表格中:

本文章重点讲解实现的思路和流程,

所以,没有详尽无遗,也没有给出实际代码,

然而,这个想法几乎是网络抓取的一般例程。

把它写在这里,当你想到任何东西时更新它。

如果写的有问题,请见谅!

网页抓取的基本原理 - 白话

原版的: 查看全部

网页新闻抓取(Python代码的适用实例有哪些?WebScraping的基本原理步骤)

本文主要介绍Web Scraping的基本原理,基于Python语言,白话,面向可爱小白(^-^)。

令人困惑的名字:

很多时候,人们会将网上获取数据的代码称为“爬虫”。

但其实所谓的“爬虫”并不是特别准确,因为“爬虫”也是分类的,

有两种常见的“爬行动物”:

网络爬虫,也称为蜘蛛;Spiderbot Web Scraper,也称为 Web Harvesting;网络数据提取

不过,这文章主要说明了第二种“网络爬虫”的原理。

什么是网页抓取?

简单地说,Web Scraping,(在本文中)是指使用 Python 代码从肉眼可见的网页中抓取数据。

为什么需要网页抓取?

因为,重复太多的工作,自己做,可能会很累!

有哪些适用的代码示例?例如,您需要下载证券交易所 50 种不同股票的当前价格,或者,您想打印出新闻 网站 上所有最新新闻的头条新闻,或者,只是想把网站上的所有商品,列出价格,放到Excel中对比,等等,尽情发挥你的想象力吧……

Web Scraping的基本原理:

首先,您需要了解网页是如何在我们的屏幕上呈现的;

其实我们发送一个Request,然后100公里外的服务器给我们返回一个Response;然后我们看了很多文字,最后,浏览器偷偷把文字排版,放到我们的屏幕上;更详细的原理可以看我之前的博文HTTP下午茶-小白简介

然后,我们需要了解如何使用 Python 来实现它。实现原理基本上有四个步骤:

首先,代码需要向服务器发送一个Request,然后接收一个Response(html文件)。然后,我们需要对接收到的 Response 进行处理,找到我们需要的文本。然后,我们需要设计代码流来处理重复性任务。最后,导出我们得到的数据,最好在摘要末尾的一个漂亮的 Excel 电子表格中:

本文章重点讲解实现的思路和流程,

所以,没有详尽无遗,也没有给出实际代码,

然而,这个想法几乎是网络抓取的一般例程。

把它写在这里,当你想到任何东西时更新它。

如果写的有问题,请见谅!

网页抓取的基本原理 - 白话

原版的:

网页新闻抓取( 今日头条这类资讯聚合平台是基于数据挖掘技术,筛选和推荐新闻)

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2022-03-29 08:09

今日头条这类资讯聚合平台是基于数据挖掘技术,筛选和推荐新闻)

今日头条等信息聚合平台基于数据挖掘技术对新闻进行筛选和推荐:“为用户推荐有价值的、个性化的信息,提供连接人和信息的新服务。是中国发展最快的移动互联网领域之一。”自2012年3月成立以来,今日头条累计活跃用户3.1亿,日活跃用户超过3000万。

本文试图从技术层面分析今日头条的传播机制和相关原理。

网络爬虫:抓取新闻的基本技术

今日头条是典型的数据新闻平台。除合作媒体外,其新闻来源很大一部分来自搜索引擎的网络爬虫。

什么是网络爬虫?

STEP 1:从互联网的各个角落采集信息;

STEP 2:总结其中的新闻信息;

STEP 3:基于机器学习对聚合信息进行分类整理,划分每个时刻的热点新闻。

作为数据新闻平台,今日头条与一般数据新闻的不同之处在于,它提供了一个展示聚合信息的媒体平台,而不是单一的信息。

网络爬虫如何工作?

网络爬虫的工作机制依赖于互联网上的超链接网络。

Internet 上的大多数网页都有超链接。这些超链接将各种网页链接在一起,形成一个巨大的网络,即超链接网络。爬虫作为一种网络程序,从一些网页开始,保存网页的内容,在网页中搜索超链接,然后访问这些超链接,并重复上述过程。这个过程可以继续。如图所示:

如何计算“今日头条”:“网络爬虫+相似度矩阵”的技术操作流程

STEP 1:爬虫从种子节点 0 开始爬取网页内容,

STEP 2:爬取时发现两个超链接,爬取一级节点,

STEP 3:从一级节点发现二级节点,继续这个过程。

在这个过程中有两种策略:

1、只有当一个关卡的所有页面都用完后,才会爬到下一个关卡。这种策略被称为“广度优先”;

2、发现超链接后,立即开始爬取页面,并继续深入挖掘,这个过程称为“深度优先”。

附加说明:

上图是一个树状网络。真正的网络不是那么简单。它充满了“循环”,即新发现的网页中的超链接指向已被爬取的旧节点。这时候就需要识别那些已经成功爬取的页面了。

吃个栗子——

以今日头条为例,说明网络爬虫在新闻抓取中的工作流程:

STEP 1:工作人员首先要在后台设置一个新闻来源词典,如“网易新闻”、“新浪新闻”、“凤凰新闻”、“浙江新闻”等,

第 2 步:通过这些字典,网络爬虫将锁定到这些 网站 超链接并从中抓取新闻。

附加说明:

如果新闻是在与这些新闻平台相关的博客内容中,而不是新闻平台本身的新闻,网络爬虫将无法捕捉到它。

聚合媒体的概念并不是那么简单。除了聚合来自不同媒体的内容外,聚合媒体更重要的特点是对不同的信息进行分类和排序,得到一个信息聚合接口(聚合器)。各种排行榜。这种排名在传播机制上满足了网络科学中的“优先链接机制”,即用户的注意力更倾向于排名靠前的信息。这个过程可以在经典的传播科学中找到:“乐队浮动效应”。这一发现起源于美国的选举过程。候选人会站在乐队花车上获得选票,支持者会站在他的车里。研究发现,人们倾向于登上载满人的花车,

推荐系统:个性化新闻的技术逻辑

个性化推荐在今日头条中发挥着重要作用。

今日头条的用户登录非常人性化。作为后起之秀,今日头条战略性地允许用户使用微博、QQ等社交账号登录。这个过程实际上使今日头条能够挖掘个人社交网络上的基本信息。因此,可以方便地获取用户的个性化信息,例如用户的兴趣和用户属性。越用越了解用户,从而做出精准的阅读内容推荐。

个性化推荐的基础是构建推荐系统

推荐系统广泛用于用户没有明确需求的场景。在算法方面,推荐系统可以分为:

社交推荐(如咨询朋友);

基于内容的过滤(例如,根据用户看过的电影推荐其他类似的电影);

基于协同过滤的推荐(协同过滤,比如查看排行榜,或者找到兴趣相似的用户,看看他们最近看过什么电影)。

因此,可以用来构建推荐系统的信息也分为三类:好友、历史兴趣、注册信息。

推荐系统是一种自动化工具,可以将用户与项目相关联。除了这些信息之外,还可以在推荐系统的构建中加入时间、位置等信息。现在,推荐系统已经广泛应用于新闻推荐、书籍推荐、音乐推荐、电影推荐、好友推荐等领域。作为人工智能的一种形式,它极大地方便了人们的生活和交流。

推荐系统算法的基础是构造相似度矩阵

这个相似度矩阵可以是物体之间的相似度,比如书籍之间的相似度,音乐之间的相似度。以下是基于项目的协同过滤 (ItemCF) 的示例。基于项目的协同过滤算法可以利用用户的历史行为,从而使推荐结果具有高度可解释性。例如,可以向喜欢阅读足球新闻的用户推荐其他类似新闻。基于item的协同过滤算法主要分为两个步骤:

第 1 步:计算项目之间的相似度。

STEP 2:根据用户的历史行为生成用户推荐列表。

假设有四个用户:

用户1在今日头条的浏览记录为[a,b,d],

用户2的浏览记录为[b, c],

用户 3 的浏览记录为 [c, d],

用户4的浏览记录为[b,c,d];

这四个人的浏览行为可以表示为以下四个项目矩阵:

添加单个用户的项目矩阵可以聚合成所有的新闻矩阵 M,其中 M[i][j] 表示新闻 i 和新闻 j 被多人同时阅读的次数。如下:

矩阵逻辑

如果两个新闻故事被多个人同时观看,则可以说它们更相似。

对上述矩阵进行归一化可以对矩阵进行操作,计算新闻之间的相似度,例如相关相似度或余弦相似度。

基于item之间的相似度,如果一个新用户进入系统,他阅读了新闻c,ItemCF算法可以快速将相似度最高的新闻(b和d)赋予新闻c,并推荐给这个新用户。

在推荐过程中,推荐系统可以根据用户的行为不断优化相似度矩阵,使推荐越来越准确。

或者,如果用户可以手动标记每个新闻项目的兴趣(喜欢或不喜欢),则可以使推荐更加准确。

本质上,以上两个数字是热点新闻和个人定制新闻的基本原理。它分两步完成:

STEP 1:首先找出新闻之间的热点和相似之处

STEP 2:向用户推送相似度高的热点新闻。

吃个栗子——

假设抗战胜利70周年,有4个人同时浏览今日头条,

A是一位女性读者。她点开了秋季糖水怎么做、育儿要注意的五件事、阅兵、新武器等新闻。

B 是一名中年上班族。他点击阅兵式和中国最新武器目录等新闻。

C是老人,点击了医疗保健、阅兵、新武器等新闻。

D是刚毕业的男大学生。他点开了英雄联盟攻略、好莱坞旅游攻略、阅兵、新武器等新闻。

热点和相似度的生成过程:

STEP 1:这四个人同时点击阅兵和新武器,系统算法会通过点击和停留时间计算出阅兵和新武器是当天的热点。

STEP 2:游行和新武器被多人同时点击,这意味着它们有相似之处。

STEP 3:当新用户点击新闻时,今日头条会以最快的速度分析其点击的内容,并在已签出的热点新闻中找到其感兴趣的相关内容,并引导其阅读热点新闻。

这一系列的行为都是由计算机自动完成的。

机制缺陷

上面的例子说明了定制新闻是基于泛热点新闻的。这就带来了一个问题,即当关注的新闻不是热点时,系统将无法获取相关的热点,而将其纳入新闻中。寻找其他信息再次匹配,使匹配的新闻在现有信息的基础上最大程度匹配用户的兴趣,但可能不会推送当天最热的新闻。实现这种长尾理论所设想的定制的关键是新闻的细分。只有将不同的主题细分为各种子主题,再细分从属内容,才能实现真正的个性化定制。做到这一点,其实已经脱离了机械,而是在于人们对事物本质的认知和把握。正如法国社会学家福柯在《知识考古学》中所指出的,分类是一物与另一物的根本区别。分类归根结底是人类主观能动性的体现;系统中积累的用户行为越多,分类越准确,自动化的个性化定制就越贴近用户需求。

聚合媒体:国际新闻的趋势

聚合媒体在国外的应用也非常广泛。聚合媒体数据新闻平台的信息展示可以是传统搜索引擎的平面展示,也可以是视觉展示。后者如日本的新闻地图网站()。日本新闻地图项目基于谷歌新闻。它使用不同的颜色来区分新闻类别,例如红色代表“世界”,黄色代表“国家”。用户可以通过检查页面底部的类别栏进行过滤。您可以在页面顶部按国家和地区进行过滤。网站后台算法根据相关新闻信息的数量、重要性和点击量,自动调整每条新闻所占区域的大小。

一个非常有趣的联合新闻网站 是 GDELT。GDELT 项目(The GDELT Project,)监控全球 100 多种语言的实时广播、印刷和在线新闻,识别世界各地的人、地点、组织、卷、主题、来源、情绪和时间消息。基于此,GDELT 推出了全球新闻情绪地图,每小时更新一次。绿色代表快乐,黄色代表悲伤。数据密度反映了新闻的规模,如下图所示:

另一个很好的例子是社交新闻网站,主要在Digg、Reddit等。这种类型的网站允许用户注册、互相关注、提交新闻、评价新闻。其中,得分高的新闻将进入热门新闻页面。在这个过程中,每个用户都充当着新闻把关人的角色,这种信息把关方式称为群组把关。

但是群看门的意义主要是把新闻推送到热门新闻的网页上,也就是向大众推送。这个阶段之后,大众信息的传播更像是传统媒体的新闻传播方式。其实这种基于用户过滤的新闻聚合很常见,比如新浪微博上的“热点话题”、推特上的“潮流话题”等等。根据笔者在Digg上的新闻传播分析,这种新闻聚合对信息传播的影响更大。对于那些广为传播的Digg新闻,Digg用户70%以上的信息接触是通过热门新闻看到的。

主流新闻视图和人工智能

从媒体把关到人群把关是一个进步,但从人群把关到计算机或算法把关存在隐患。

以前由编辑承担的内容选择工作现在由计算机处理。其信息把关机制发生了根本性变化。在这个过程中,传统的新闻生产逻辑受到的影响最大。传统的新闻观重视公共利益,报道具有长期影响的事件并提供见解。将这项工作交给机器和算法将带来前所未有的挑战:

首先,算法根据用户表现出的“兴趣”对信息进行分类推荐,往往容易在短期内向用户推荐一些用户喜欢的低质量信息。

其次,不断接触低质量信息会降低个人的新闻素养。过分依赖机器帮我们查资料,容易导致视野越来越局限,不再关注社会的整体利益,容易走向犬儒主义。

第三,主流的新闻运作方式保证了新闻从业者在面对政治、军事和社会力量时的独立和冷静。推荐算法从信息和用户出发,对国家和社会整体关注不够。这种新闻推送机制的偏见很容易带来批评。

未来,新闻业将走向人机融合时代

从未来新闻的角度思考新闻产业的转型,让我们意识到回归新闻本质的重要性。

未来的新闻业不仅提供有限的案例采访,而是系统地获取、积累和分析数据,挖掘隐藏的信息。在注意力经济时代,媒体有责任为用户提供这样的专业信息和专业评论。迅速崛起的数据新闻正朝着这个方向发展,但现阶段更注重视觉表达。聚合媒体自动过滤信息,反映未来新闻的特点。基于个性化推荐,聚合媒体进一步将人工智能的新闻整合功能带入我们的生活,提供了很多便利。然而,不应忽视的是过度依赖机器和算法所固有的危险:

新闻业的未来正在走向人机融合的时代。 查看全部

网页新闻抓取(

今日头条这类资讯聚合平台是基于数据挖掘技术,筛选和推荐新闻)

今日头条等信息聚合平台基于数据挖掘技术对新闻进行筛选和推荐:“为用户推荐有价值的、个性化的信息,提供连接人和信息的新服务。是中国发展最快的移动互联网领域之一。”自2012年3月成立以来,今日头条累计活跃用户3.1亿,日活跃用户超过3000万。

本文试图从技术层面分析今日头条的传播机制和相关原理。

网络爬虫:抓取新闻的基本技术

今日头条是典型的数据新闻平台。除合作媒体外,其新闻来源很大一部分来自搜索引擎的网络爬虫。

什么是网络爬虫?

STEP 1:从互联网的各个角落采集信息;

STEP 2:总结其中的新闻信息;

STEP 3:基于机器学习对聚合信息进行分类整理,划分每个时刻的热点新闻。

作为数据新闻平台,今日头条与一般数据新闻的不同之处在于,它提供了一个展示聚合信息的媒体平台,而不是单一的信息。

网络爬虫如何工作?

网络爬虫的工作机制依赖于互联网上的超链接网络。

Internet 上的大多数网页都有超链接。这些超链接将各种网页链接在一起,形成一个巨大的网络,即超链接网络。爬虫作为一种网络程序,从一些网页开始,保存网页的内容,在网页中搜索超链接,然后访问这些超链接,并重复上述过程。这个过程可以继续。如图所示:

如何计算“今日头条”:“网络爬虫+相似度矩阵”的技术操作流程

STEP 1:爬虫从种子节点 0 开始爬取网页内容,

STEP 2:爬取时发现两个超链接,爬取一级节点,

STEP 3:从一级节点发现二级节点,继续这个过程。

在这个过程中有两种策略:

1、只有当一个关卡的所有页面都用完后,才会爬到下一个关卡。这种策略被称为“广度优先”;

2、发现超链接后,立即开始爬取页面,并继续深入挖掘,这个过程称为“深度优先”。

附加说明:

上图是一个树状网络。真正的网络不是那么简单。它充满了“循环”,即新发现的网页中的超链接指向已被爬取的旧节点。这时候就需要识别那些已经成功爬取的页面了。

吃个栗子——

以今日头条为例,说明网络爬虫在新闻抓取中的工作流程:

STEP 1:工作人员首先要在后台设置一个新闻来源词典,如“网易新闻”、“新浪新闻”、“凤凰新闻”、“浙江新闻”等,

第 2 步:通过这些字典,网络爬虫将锁定到这些 网站 超链接并从中抓取新闻。

附加说明:

如果新闻是在与这些新闻平台相关的博客内容中,而不是新闻平台本身的新闻,网络爬虫将无法捕捉到它。

聚合媒体的概念并不是那么简单。除了聚合来自不同媒体的内容外,聚合媒体更重要的特点是对不同的信息进行分类和排序,得到一个信息聚合接口(聚合器)。各种排行榜。这种排名在传播机制上满足了网络科学中的“优先链接机制”,即用户的注意力更倾向于排名靠前的信息。这个过程可以在经典的传播科学中找到:“乐队浮动效应”。这一发现起源于美国的选举过程。候选人会站在乐队花车上获得选票,支持者会站在他的车里。研究发现,人们倾向于登上载满人的花车,

推荐系统:个性化新闻的技术逻辑

个性化推荐在今日头条中发挥着重要作用。

今日头条的用户登录非常人性化。作为后起之秀,今日头条战略性地允许用户使用微博、QQ等社交账号登录。这个过程实际上使今日头条能够挖掘个人社交网络上的基本信息。因此,可以方便地获取用户的个性化信息,例如用户的兴趣和用户属性。越用越了解用户,从而做出精准的阅读内容推荐。

个性化推荐的基础是构建推荐系统

推荐系统广泛用于用户没有明确需求的场景。在算法方面,推荐系统可以分为:

社交推荐(如咨询朋友);

基于内容的过滤(例如,根据用户看过的电影推荐其他类似的电影);

基于协同过滤的推荐(协同过滤,比如查看排行榜,或者找到兴趣相似的用户,看看他们最近看过什么电影)。

因此,可以用来构建推荐系统的信息也分为三类:好友、历史兴趣、注册信息。

推荐系统是一种自动化工具,可以将用户与项目相关联。除了这些信息之外,还可以在推荐系统的构建中加入时间、位置等信息。现在,推荐系统已经广泛应用于新闻推荐、书籍推荐、音乐推荐、电影推荐、好友推荐等领域。作为人工智能的一种形式,它极大地方便了人们的生活和交流。

推荐系统算法的基础是构造相似度矩阵

这个相似度矩阵可以是物体之间的相似度,比如书籍之间的相似度,音乐之间的相似度。以下是基于项目的协同过滤 (ItemCF) 的示例。基于项目的协同过滤算法可以利用用户的历史行为,从而使推荐结果具有高度可解释性。例如,可以向喜欢阅读足球新闻的用户推荐其他类似新闻。基于item的协同过滤算法主要分为两个步骤:

第 1 步:计算项目之间的相似度。

STEP 2:根据用户的历史行为生成用户推荐列表。

假设有四个用户:

用户1在今日头条的浏览记录为[a,b,d],

用户2的浏览记录为[b, c],

用户 3 的浏览记录为 [c, d],

用户4的浏览记录为[b,c,d];

这四个人的浏览行为可以表示为以下四个项目矩阵:

添加单个用户的项目矩阵可以聚合成所有的新闻矩阵 M,其中 M[i][j] 表示新闻 i 和新闻 j 被多人同时阅读的次数。如下:

矩阵逻辑

如果两个新闻故事被多个人同时观看,则可以说它们更相似。

对上述矩阵进行归一化可以对矩阵进行操作,计算新闻之间的相似度,例如相关相似度或余弦相似度。

基于item之间的相似度,如果一个新用户进入系统,他阅读了新闻c,ItemCF算法可以快速将相似度最高的新闻(b和d)赋予新闻c,并推荐给这个新用户。

在推荐过程中,推荐系统可以根据用户的行为不断优化相似度矩阵,使推荐越来越准确。

或者,如果用户可以手动标记每个新闻项目的兴趣(喜欢或不喜欢),则可以使推荐更加准确。

本质上,以上两个数字是热点新闻和个人定制新闻的基本原理。它分两步完成:

STEP 1:首先找出新闻之间的热点和相似之处

STEP 2:向用户推送相似度高的热点新闻。

吃个栗子——

假设抗战胜利70周年,有4个人同时浏览今日头条,

A是一位女性读者。她点开了秋季糖水怎么做、育儿要注意的五件事、阅兵、新武器等新闻。

B 是一名中年上班族。他点击阅兵式和中国最新武器目录等新闻。

C是老人,点击了医疗保健、阅兵、新武器等新闻。

D是刚毕业的男大学生。他点开了英雄联盟攻略、好莱坞旅游攻略、阅兵、新武器等新闻。

热点和相似度的生成过程:

STEP 1:这四个人同时点击阅兵和新武器,系统算法会通过点击和停留时间计算出阅兵和新武器是当天的热点。

STEP 2:游行和新武器被多人同时点击,这意味着它们有相似之处。

STEP 3:当新用户点击新闻时,今日头条会以最快的速度分析其点击的内容,并在已签出的热点新闻中找到其感兴趣的相关内容,并引导其阅读热点新闻。

这一系列的行为都是由计算机自动完成的。

机制缺陷

上面的例子说明了定制新闻是基于泛热点新闻的。这就带来了一个问题,即当关注的新闻不是热点时,系统将无法获取相关的热点,而将其纳入新闻中。寻找其他信息再次匹配,使匹配的新闻在现有信息的基础上最大程度匹配用户的兴趣,但可能不会推送当天最热的新闻。实现这种长尾理论所设想的定制的关键是新闻的细分。只有将不同的主题细分为各种子主题,再细分从属内容,才能实现真正的个性化定制。做到这一点,其实已经脱离了机械,而是在于人们对事物本质的认知和把握。正如法国社会学家福柯在《知识考古学》中所指出的,分类是一物与另一物的根本区别。分类归根结底是人类主观能动性的体现;系统中积累的用户行为越多,分类越准确,自动化的个性化定制就越贴近用户需求。

聚合媒体:国际新闻的趋势

聚合媒体在国外的应用也非常广泛。聚合媒体数据新闻平台的信息展示可以是传统搜索引擎的平面展示,也可以是视觉展示。后者如日本的新闻地图网站()。日本新闻地图项目基于谷歌新闻。它使用不同的颜色来区分新闻类别,例如红色代表“世界”,黄色代表“国家”。用户可以通过检查页面底部的类别栏进行过滤。您可以在页面顶部按国家和地区进行过滤。网站后台算法根据相关新闻信息的数量、重要性和点击量,自动调整每条新闻所占区域的大小。

一个非常有趣的联合新闻网站 是 GDELT。GDELT 项目(The GDELT Project,)监控全球 100 多种语言的实时广播、印刷和在线新闻,识别世界各地的人、地点、组织、卷、主题、来源、情绪和时间消息。基于此,GDELT 推出了全球新闻情绪地图,每小时更新一次。绿色代表快乐,黄色代表悲伤。数据密度反映了新闻的规模,如下图所示:

另一个很好的例子是社交新闻网站,主要在Digg、Reddit等。这种类型的网站允许用户注册、互相关注、提交新闻、评价新闻。其中,得分高的新闻将进入热门新闻页面。在这个过程中,每个用户都充当着新闻把关人的角色,这种信息把关方式称为群组把关。

但是群看门的意义主要是把新闻推送到热门新闻的网页上,也就是向大众推送。这个阶段之后,大众信息的传播更像是传统媒体的新闻传播方式。其实这种基于用户过滤的新闻聚合很常见,比如新浪微博上的“热点话题”、推特上的“潮流话题”等等。根据笔者在Digg上的新闻传播分析,这种新闻聚合对信息传播的影响更大。对于那些广为传播的Digg新闻,Digg用户70%以上的信息接触是通过热门新闻看到的。

主流新闻视图和人工智能

从媒体把关到人群把关是一个进步,但从人群把关到计算机或算法把关存在隐患。

以前由编辑承担的内容选择工作现在由计算机处理。其信息把关机制发生了根本性变化。在这个过程中,传统的新闻生产逻辑受到的影响最大。传统的新闻观重视公共利益,报道具有长期影响的事件并提供见解。将这项工作交给机器和算法将带来前所未有的挑战:

首先,算法根据用户表现出的“兴趣”对信息进行分类推荐,往往容易在短期内向用户推荐一些用户喜欢的低质量信息。

其次,不断接触低质量信息会降低个人的新闻素养。过分依赖机器帮我们查资料,容易导致视野越来越局限,不再关注社会的整体利益,容易走向犬儒主义。

第三,主流的新闻运作方式保证了新闻从业者在面对政治、军事和社会力量时的独立和冷静。推荐算法从信息和用户出发,对国家和社会整体关注不够。这种新闻推送机制的偏见很容易带来批评。

未来,新闻业将走向人机融合时代

从未来新闻的角度思考新闻产业的转型,让我们意识到回归新闻本质的重要性。

未来的新闻业不仅提供有限的案例采访,而是系统地获取、积累和分析数据,挖掘隐藏的信息。在注意力经济时代,媒体有责任为用户提供这样的专业信息和专业评论。迅速崛起的数据新闻正朝着这个方向发展,但现阶段更注重视觉表达。聚合媒体自动过滤信息,反映未来新闻的特点。基于个性化推荐,聚合媒体进一步将人工智能的新闻整合功能带入我们的生活,提供了很多便利。然而,不应忽视的是过度依赖机器和算法所固有的危险:

新闻业的未来正在走向人机融合的时代。

网页新闻抓取(爬虫来讲下爬虫,爬取新浪新闻)

网站优化 • 优采云 发表了文章 • 0 个评论 • 227 次浏览 • 2022-03-28 12:10

说到python,大家经常会提到爬虫。我认为最近爬虫兴起的原因主要是因为大数据。大数据导致我们的数据不仅仅存在于我们自己的服务器上,python语言的简洁也成为了爬虫工具的主要语言,我们将在这篇文章中谈到爬虫文章,爬取新浪新闻

1、众所周知,爬虫其实是模拟浏览器请求,然后通过我们对请求数据的分析,提取出我们想要的内容,这就是爬虫的实现。众所周知,爬虫其实就是一个模拟浏览器请求,然后通过我们对请求数据的分析,提取出我们想要的内容,这就是爬虫的实现

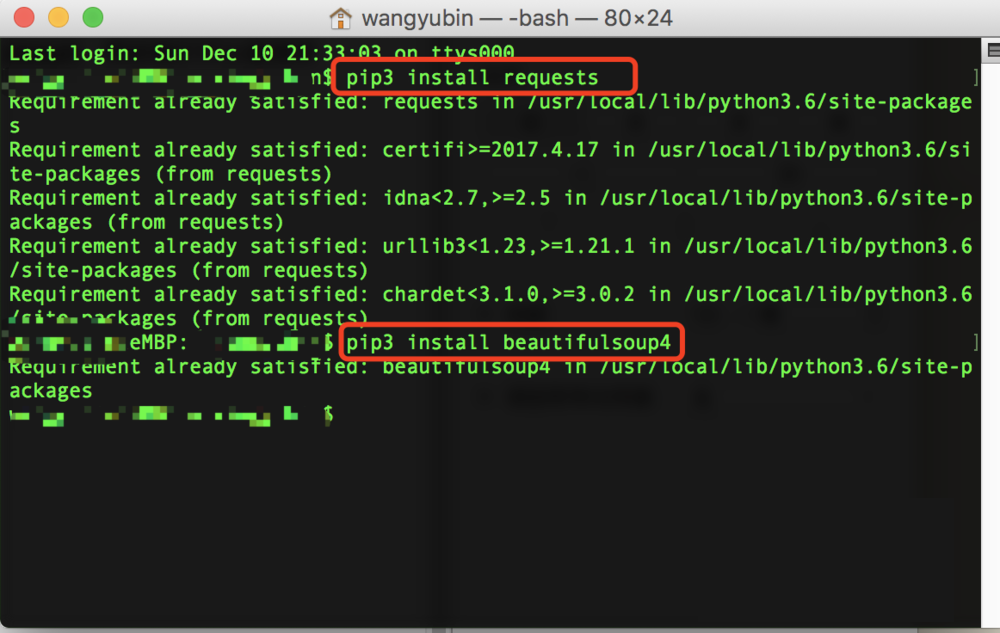

2、首先要写爬虫,可以借鉴一些工具,先简单介绍一下,首先说到requests,会想到python中非常有用的requests,还有那么在分析解析的时候,我们会使用到bs4,那么我们可以直接使用pip命令来实现安装,如果安装的是python3,我们也可以使用pip3

3、安装完这两个库后,我们可以先请求数据,查看消息的内容。这时候我们可能会看到乱码

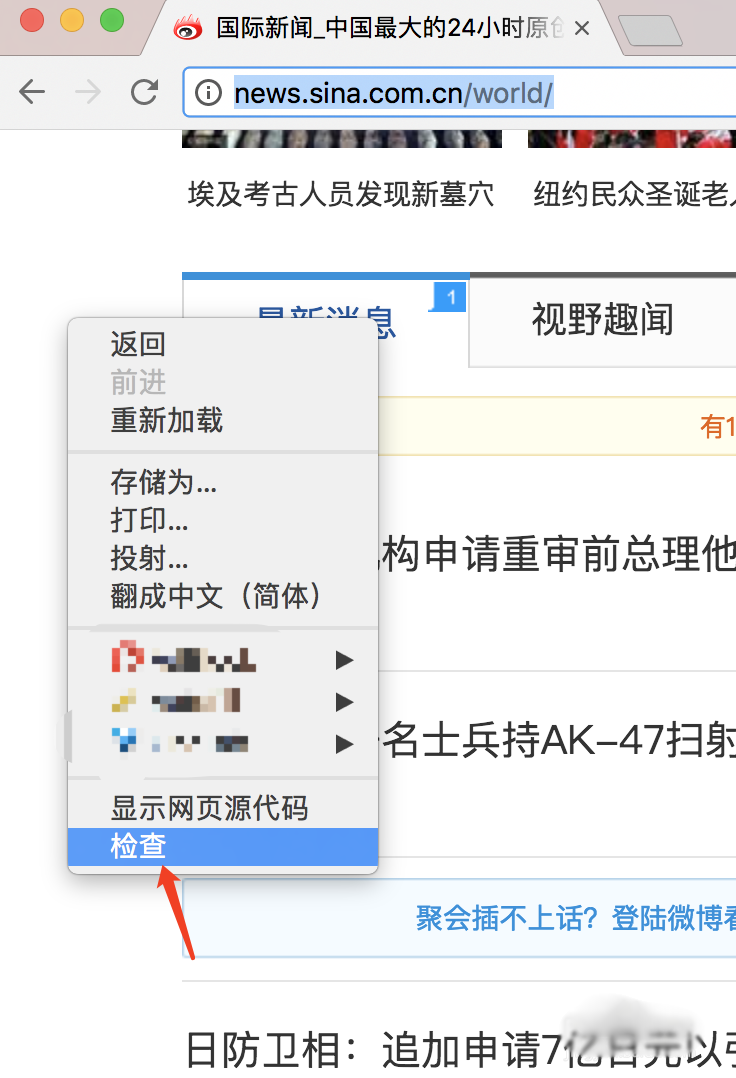

4、乱码怎么处理?我们可以用浏览器打开网页,右键查看网页的源码,可以看到编码格式为utf-8

5、然后我们在输出的时候加上编码格式,就可以查看正确编码的数据了

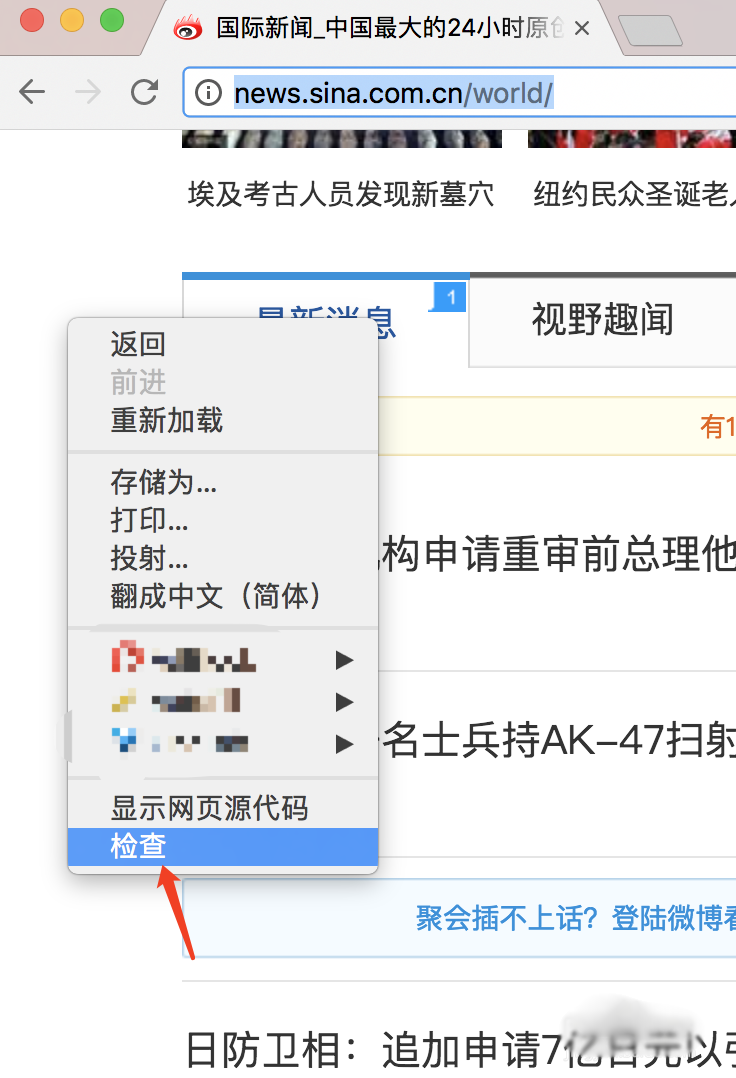

6、拿到数据后,我们需要先对数据进行分析,看看我们想要的数据在哪里。我们打开浏览器,右击查看,然后按示例图片可以看到我们的新闻所在的标签。如果是windows系统,选择和开发中的工具一样

7、知道它属于哪个标签后,我们使用bs4解析得到我们想要的数据

8、如果要获取新闻的具体标题、时间、地址,需要对元素进行深入分析。我们还是按照之前的方法找到标题所在的标签

9、然后我们为标题时间地址写一个python程序,就可以爬出对应的标题内容、时间和地址

10、简单的python爬取新闻来了

总结:以上就是Python爬虫获取新浪新闻内容的步骤。感谢您阅读和支持 Scripting Home。 查看全部

网页新闻抓取(爬虫来讲下爬虫,爬取新浪新闻)

说到python,大家经常会提到爬虫。我认为最近爬虫兴起的原因主要是因为大数据。大数据导致我们的数据不仅仅存在于我们自己的服务器上,python语言的简洁也成为了爬虫工具的主要语言,我们将在这篇文章中谈到爬虫文章,爬取新浪新闻

1、众所周知,爬虫其实是模拟浏览器请求,然后通过我们对请求数据的分析,提取出我们想要的内容,这就是爬虫的实现。众所周知,爬虫其实就是一个模拟浏览器请求,然后通过我们对请求数据的分析,提取出我们想要的内容,这就是爬虫的实现

2、首先要写爬虫,可以借鉴一些工具,先简单介绍一下,首先说到requests,会想到python中非常有用的requests,还有那么在分析解析的时候,我们会使用到bs4,那么我们可以直接使用pip命令来实现安装,如果安装的是python3,我们也可以使用pip3

3、安装完这两个库后,我们可以先请求数据,查看消息的内容。这时候我们可能会看到乱码

4、乱码怎么处理?我们可以用浏览器打开网页,右键查看网页的源码,可以看到编码格式为utf-8

5、然后我们在输出的时候加上编码格式,就可以查看正确编码的数据了

6、拿到数据后,我们需要先对数据进行分析,看看我们想要的数据在哪里。我们打开浏览器,右击查看,然后按示例图片可以看到我们的新闻所在的标签。如果是windows系统,选择和开发中的工具一样

7、知道它属于哪个标签后,我们使用bs4解析得到我们想要的数据

8、如果要获取新闻的具体标题、时间、地址,需要对元素进行深入分析。我们还是按照之前的方法找到标题所在的标签

9、然后我们为标题时间地址写一个python程序,就可以爬出对应的标题内容、时间和地址

10、简单的python爬取新闻来了

总结:以上就是Python爬虫获取新浪新闻内容的步骤。感谢您阅读和支持 Scripting Home。

网页新闻抓取(谷歌对媒体披露APP页面内容不再是信息孤岛(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-03-28 12:09

谷歌工程师 Rajan Patel 向媒体透露,APP 页面的内容不再是信息孤岛。从两年前开始,谷歌就一直在抓取外部应用的内部链接和内容,累计抓取超过300次。十亿。

在传统网页中,谷歌可以通过软件“蜘蛛”自动访问和爬取,无需获得网站管理员的许可。

在App内容的抓取中,谷歌需要与应用软件开发商建立合作关系。谷歌提供了相应的软件开发接口(API),开发者可以通过这些接口向谷歌搜索开放数据,从而实现对搜索引擎的内容爬取。

据悉,与谷歌合作的移动端软件众多,包括微博Twitter、短租工具Airbnb、消费者点评工具Yelp、手机订餐工具OpenTable、照片采集社交网络Pinterest、房产搜索工具特鲁利亚等。

当然,还有大量的移动媒体应用,也被谷歌用于新闻报道。

与谷歌抓取的网页数据库相比,超过 300 亿个链接的内容微不足道。此前的报道称,谷歌蜘蛛抓取了数百亿个网页。

然而,在智能手机时代,人们使用搜索更有目的性,拥有更多的场景信息。因此,主流的APP和超过300亿的链接足以为用户提供他们所需要的信息。

据介绍,在之前的手机搜索中,谷歌客户端会观察用户的智能手机上安装了哪些应用,而谷歌只会返回已安装应用的搜索结果。

日前,谷歌团队也宣布对搜索结果中收录的应用进行了修改。即使用户没有安装应用程序,只要其内容相关,它的内容也会出现在搜索结果中。

例如,如果用户的手机上没有安装 OpenTable,这是一种订餐工具,但在搜索餐厅时,Google 可能仍会呈现来自 OpenTable 的消费者评论。 查看全部

网页新闻抓取(谷歌对媒体披露APP页面内容不再是信息孤岛(图))

谷歌工程师 Rajan Patel 向媒体透露,APP 页面的内容不再是信息孤岛。从两年前开始,谷歌就一直在抓取外部应用的内部链接和内容,累计抓取超过300次。十亿。

在传统网页中,谷歌可以通过软件“蜘蛛”自动访问和爬取,无需获得网站管理员的许可。

在App内容的抓取中,谷歌需要与应用软件开发商建立合作关系。谷歌提供了相应的软件开发接口(API),开发者可以通过这些接口向谷歌搜索开放数据,从而实现对搜索引擎的内容爬取。

据悉,与谷歌合作的移动端软件众多,包括微博Twitter、短租工具Airbnb、消费者点评工具Yelp、手机订餐工具OpenTable、照片采集社交网络Pinterest、房产搜索工具特鲁利亚等。

当然,还有大量的移动媒体应用,也被谷歌用于新闻报道。

与谷歌抓取的网页数据库相比,超过 300 亿个链接的内容微不足道。此前的报道称,谷歌蜘蛛抓取了数百亿个网页。

然而,在智能手机时代,人们使用搜索更有目的性,拥有更多的场景信息。因此,主流的APP和超过300亿的链接足以为用户提供他们所需要的信息。

据介绍,在之前的手机搜索中,谷歌客户端会观察用户的智能手机上安装了哪些应用,而谷歌只会返回已安装应用的搜索结果。

日前,谷歌团队也宣布对搜索结果中收录的应用进行了修改。即使用户没有安装应用程序,只要其内容相关,它的内容也会出现在搜索结果中。

例如,如果用户的手机上没有安装 OpenTable,这是一种订餐工具,但在搜索餐厅时,Google 可能仍会呈现来自 OpenTable 的消费者评论。

网页新闻抓取(Web浏览器APIiMacros组件.NET组件可以远程控制浏览器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-03-28 01:16

添加:

提升:

维修:

网络自动化

iMacros 是一个可以记录和回放工作的网络自动化软件。它的主要功能是:

iMacros 可以帮助您每天检查网站,记住密码,填写网络表格,让您从繁琐的工作中解脱出来。iMacros 是唯一可以自动填写网络表单的软件。它将所有信息存储在文本文件中,以便于编辑和阅读。密码使用 256 位 AES 加密。

数据提取

iMacros 不仅可以填写网页表单信息,还可以提取信息。例如:从 网站 中查找并提取文本、图像(如价格、产品描述、股票报价等)。iMacros支持Unicode格式和所有语言(包括中文等多字节语言)。

网络测试

iMacros 可以对 Web 应用程序进行功能测试、性能测试和回归测试。iMacros 是唯一可以在 IE、Firefox 和 Chrome 等浏览器中直接测试的工具。它还可以在 Java/Flash/Flex/Silverlight 程序和所有 AJAX 元素中执行测试。iMacros 内置命令命令,可以准确捕捉 Web 的每一次响应时间。

网络浏览器 API

iMacros 的脚本接口支持网络浏览器可编程控制。因此,可以编写脚本来完成复杂的任务。iMacros 的 32/64 位 API 可以远程控制浏览器。

.NET Web 浏览器组件

.NET Web 浏览器组件可以快速将自动化添加到您的应用程序中。它在测试和调试方面拥有十多年的成熟技术。目前有超过 500,000 名用户在使用。

系统要求 查看全部

网页新闻抓取(Web浏览器APIiMacros组件.NET组件可以远程控制浏览器)

添加:

提升:

维修:

网络自动化

iMacros 是一个可以记录和回放工作的网络自动化软件。它的主要功能是:

iMacros 可以帮助您每天检查网站,记住密码,填写网络表格,让您从繁琐的工作中解脱出来。iMacros 是唯一可以自动填写网络表单的软件。它将所有信息存储在文本文件中,以便于编辑和阅读。密码使用 256 位 AES 加密。

数据提取

iMacros 不仅可以填写网页表单信息,还可以提取信息。例如:从 网站 中查找并提取文本、图像(如价格、产品描述、股票报价等)。iMacros支持Unicode格式和所有语言(包括中文等多字节语言)。

网络测试

iMacros 可以对 Web 应用程序进行功能测试、性能测试和回归测试。iMacros 是唯一可以在 IE、Firefox 和 Chrome 等浏览器中直接测试的工具。它还可以在 Java/Flash/Flex/Silverlight 程序和所有 AJAX 元素中执行测试。iMacros 内置命令命令,可以准确捕捉 Web 的每一次响应时间。

网络浏览器 API

iMacros 的脚本接口支持网络浏览器可编程控制。因此,可以编写脚本来完成复杂的任务。iMacros 的 32/64 位 API 可以远程控制浏览器。

.NET Web 浏览器组件

.NET Web 浏览器组件可以快速将自动化添加到您的应用程序中。它在测试和调试方面拥有十多年的成熟技术。目前有超过 500,000 名用户在使用。

系统要求

网页新闻抓取(公管网络爬虫教程实战项目之任务抓取规则..)

网站优化 • 优采云 发表了文章 • 0 个评论 • 370 次浏览 • 2022-03-28 01:15

这个文章是一个非常不错的python网络爬虫教程实战项目。总的来说,爬虫是Python可以实现的一个比较简单的功能,适合新手练习。

任务

从四川大学公共管理学院官方网站获取所有新闻和查询。

实验过程

1.确定获取目标。

2.创建抓取规则。

3.'Write/debug' 抓取规则。

4.获取爬取数据

1.识别爬取目标

这次我们要抢的目标是四川大学公共管理学院的所有新闻资讯。所以我们需要知道公共管理学院官网的布局。

在这里我们发现,如果要抓取所有新闻信息,不能直接在官网首页抓取,需要点击“更多”进入综合新闻版块。

我们看到了具体的新闻板块,但这显然不能满足我们的抓取需求:目前的新闻动态网页只能抓取新闻的时间、标题和网址,而不能抓取新闻的内容。所以我们要进入新闻详情页面去抓取新闻的具体内容。

2.创建抓取规则

通过第一部分的分析,我们会认为如果要抓取一条新闻的具体信息,需要从新闻动态页面点击进入新闻详情页面,抓取新闻的具体内容。让我们点击新闻试试

我们可以在新闻部分的底部看到页面跳转按钮。然后我们可以通过“下一页”按钮抓取所有新闻。

所以整理思路后,我们可以想到一个明显的抓取规则:

通过抓取“新闻版块”下的所有新闻链接,进入新闻详情链接即可抓取所有新闻内容。

3.'Write/Debug' 抓取规则

为了让调试爬虫的粒度尽可能小,我把编写和调试模块组合在一起。

在爬虫中,我将实现以下功能点:

1.从新闻版块下的所有新闻链接中爬出一页

2.通过一个页面上爬取的新闻链接,进入新闻详情,爬取需要的数据(主要是新闻内容)

3.通过循环抓取所有新闻。

对应的知识点为:

1.爬出一个页面下的基础数据。

2.对爬取的数据进行二次爬取。

3.通过循环爬取网页的所有数据。

事不宜迟,我们现在就开始吧。

3.1 爬出页面新闻版块下的所有新闻链接

通过对新闻栏目源码的分析,我们发现抓取到的数据结构如下:

那么我们只需要将爬虫的选择器定位到(li:newsinfo_box_cf),然后执行for循环即可抓取。

编写代码

测试并通过!

3.2 通过页面上爬取的新闻链接输入爬取新闻详情(主要是新闻内容)所需的数据

现在我已经获取了一组网址,现在我需要输入每个网址来抓取我需要的标题、时间和内容。代码实现也很简单。我只需要在原创代码抓取一个URL并抓取它时输入URL。只需获取相应的数据。所以,我只需要再写一个grab方法进入新闻详情页面,并使用scapy.request调用即可。

编写代码

整合到原代码中后,有:

测试并通过!

然后我们添加一个循环:

添加到原创代码中:

测试:

捕获的数量是191,但我们在官网上找到了193条新闻,少了两条。

为什么?我们注意到日志中有两个错误:

定位问题:原来学院新闻栏目有两个隐藏的二级栏目:

例如:

对应的网址是

网址都不一样,难怪抓不到!

那么我们要对这两个二级列的url设置特殊的规则,只需要添加判断是否是二级列:

组装原函数:

测试:

4.获取爬取数据

文章到此结束。不知道大家对python网络爬虫教程有什么样的理解?此功能对您有多大用处? 查看全部

网页新闻抓取(公管网络爬虫教程实战项目之任务抓取规则..)

这个文章是一个非常不错的python网络爬虫教程实战项目。总的来说,爬虫是Python可以实现的一个比较简单的功能,适合新手练习。

任务

从四川大学公共管理学院官方网站获取所有新闻和查询。

实验过程

1.确定获取目标。

2.创建抓取规则。

3.'Write/debug' 抓取规则。

4.获取爬取数据

1.识别爬取目标

这次我们要抢的目标是四川大学公共管理学院的所有新闻资讯。所以我们需要知道公共管理学院官网的布局。

在这里我们发现,如果要抓取所有新闻信息,不能直接在官网首页抓取,需要点击“更多”进入综合新闻版块。

我们看到了具体的新闻板块,但这显然不能满足我们的抓取需求:目前的新闻动态网页只能抓取新闻的时间、标题和网址,而不能抓取新闻的内容。所以我们要进入新闻详情页面去抓取新闻的具体内容。

2.创建抓取规则

通过第一部分的分析,我们会认为如果要抓取一条新闻的具体信息,需要从新闻动态页面点击进入新闻详情页面,抓取新闻的具体内容。让我们点击新闻试试

我们可以在新闻部分的底部看到页面跳转按钮。然后我们可以通过“下一页”按钮抓取所有新闻。

所以整理思路后,我们可以想到一个明显的抓取规则:

通过抓取“新闻版块”下的所有新闻链接,进入新闻详情链接即可抓取所有新闻内容。

3.'Write/Debug' 抓取规则

为了让调试爬虫的粒度尽可能小,我把编写和调试模块组合在一起。

在爬虫中,我将实现以下功能点:

1.从新闻版块下的所有新闻链接中爬出一页

2.通过一个页面上爬取的新闻链接,进入新闻详情,爬取需要的数据(主要是新闻内容)

3.通过循环抓取所有新闻。

对应的知识点为:

1.爬出一个页面下的基础数据。

2.对爬取的数据进行二次爬取。

3.通过循环爬取网页的所有数据。

事不宜迟,我们现在就开始吧。

3.1 爬出页面新闻版块下的所有新闻链接

通过对新闻栏目源码的分析,我们发现抓取到的数据结构如下:

那么我们只需要将爬虫的选择器定位到(li:newsinfo_box_cf),然后执行for循环即可抓取。

编写代码

测试并通过!

3.2 通过页面上爬取的新闻链接输入爬取新闻详情(主要是新闻内容)所需的数据

现在我已经获取了一组网址,现在我需要输入每个网址来抓取我需要的标题、时间和内容。代码实现也很简单。我只需要在原创代码抓取一个URL并抓取它时输入URL。只需获取相应的数据。所以,我只需要再写一个grab方法进入新闻详情页面,并使用scapy.request调用即可。

编写代码

整合到原代码中后,有:

测试并通过!

然后我们添加一个循环:

添加到原创代码中:

测试:

捕获的数量是191,但我们在官网上找到了193条新闻,少了两条。

为什么?我们注意到日志中有两个错误:

定位问题:原来学院新闻栏目有两个隐藏的二级栏目:

例如:

对应的网址是

网址都不一样,难怪抓不到!

那么我们要对这两个二级列的url设置特殊的规则,只需要添加判断是否是二级列:

组装原函数:

测试:

4.获取爬取数据

文章到此结束。不知道大家对python网络爬虫教程有什么样的理解?此功能对您有多大用处?

网页新闻抓取( 通常哪些网站页面不应该被百度抓取呢?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2022-03-28 01:15

通常哪些网站页面不应该被百度抓取呢?(图))

为什么要禁止自己的网页?哪些网站页面不应该被百度抓取?

那么通常哪些网站页面不应该被百度抓取呢?比如网站里面有一定数量的重复内容,比如一些根据条件查询得到的结果页面,这在很多商场网站中是异常突出的。例如,由于一个产品的颜色、尺寸和型号的不同,会有很多相似的页面。这种页面对于用户来说可以有一定的体验,但是对于搜索引擎来说却很容易。他们因提供过多重复内容而受到处罚或降级。

另外,网站中还有很多注册页面、备份页面、测试页面。这些页面只是为了让用户更好地操作网站和自己对网站的操作进行管理。由于这些页面内容比较单调,不适合百度对内容质量的要求。所以要尽量避免被百度收录爬取。下面就详细说说如何避免百度爬取内容页面。

,使用Flash技术显示不想被百度的内容收录

这种方式不仅可以让用户获得更好的用户体验,而且百度也无法抓取这些内容,从而为用户实现更好的服务,同时不影响自身内容在百度的披露。

二、使用robots脚本技术屏蔽相应内容

目前,搜索引擎行业协会规定,机器人所描述的内容和链接被赋予收录爬取。所以对于网站上是否存在私有内容,以及管理页面、测试页面等内容,可以设置到这个脚本文件中。这不仅可以为这个网站提供很好的维护,还可以让那些看似垃圾的内容避免被百度抓取,反而会对这个网站产生巨大的负面影响。

三、使用nofollow属性标签丢弃页面上不想成为收录的内容

这种方法比较常见,可以屏蔽网页中的某个区域或者一段文字,从而提高你的网站内容的优化效果。使用这种技术,你只需要将需要屏蔽的内容的nofollow属性设置为True,就可以屏蔽该内容了。比如网站上有一些精彩的内容,但是这些内容也收录锚文本链接,所以为了防止这些锚文本外链窃取本站的权重,可以在这些内容上设置nofollow属性锚文本链接,让你享受这些内容给网站带来的流量,同时避免网站的权重被分流的危险。

四、使用Meta Noindex和follow tags

使用这种方法不仅可以防止被百度收录,还可以实现权重转移。当然具体怎么操作还要看站长的需求,但是使用这种方式屏蔽内容往往会浪费百度蜘蛛的抓取时间,从而影响优化体验,也就是说除非是不得已而为之。

对于一些站长用来屏蔽的表单模式和Javascript技术,已经不可能完成这个任务了,因为随着百度蜘蛛智能水平的提高,这些技术编辑的内容已经可以被抓取了,而且从不久的将来,一旦Flash中的内容可以被抓取,如果要屏蔽网站内容,也应该避免这种方法。

更多华旗商城产品介绍:自定义PHP网站构建婚纱摄影新模板中国山东网-枣庄软文写作技巧 查看全部

网页新闻抓取(

通常哪些网站页面不应该被百度抓取呢?(图))

为什么要禁止自己的网页?哪些网站页面不应该被百度抓取?

那么通常哪些网站页面不应该被百度抓取呢?比如网站里面有一定数量的重复内容,比如一些根据条件查询得到的结果页面,这在很多商场网站中是异常突出的。例如,由于一个产品的颜色、尺寸和型号的不同,会有很多相似的页面。这种页面对于用户来说可以有一定的体验,但是对于搜索引擎来说却很容易。他们因提供过多重复内容而受到处罚或降级。

另外,网站中还有很多注册页面、备份页面、测试页面。这些页面只是为了让用户更好地操作网站和自己对网站的操作进行管理。由于这些页面内容比较单调,不适合百度对内容质量的要求。所以要尽量避免被百度收录爬取。下面就详细说说如何避免百度爬取内容页面。

,使用Flash技术显示不想被百度的内容收录

这种方式不仅可以让用户获得更好的用户体验,而且百度也无法抓取这些内容,从而为用户实现更好的服务,同时不影响自身内容在百度的披露。

二、使用robots脚本技术屏蔽相应内容

目前,搜索引擎行业协会规定,机器人所描述的内容和链接被赋予收录爬取。所以对于网站上是否存在私有内容,以及管理页面、测试页面等内容,可以设置到这个脚本文件中。这不仅可以为这个网站提供很好的维护,还可以让那些看似垃圾的内容避免被百度抓取,反而会对这个网站产生巨大的负面影响。

三、使用nofollow属性标签丢弃页面上不想成为收录的内容

这种方法比较常见,可以屏蔽网页中的某个区域或者一段文字,从而提高你的网站内容的优化效果。使用这种技术,你只需要将需要屏蔽的内容的nofollow属性设置为True,就可以屏蔽该内容了。比如网站上有一些精彩的内容,但是这些内容也收录锚文本链接,所以为了防止这些锚文本外链窃取本站的权重,可以在这些内容上设置nofollow属性锚文本链接,让你享受这些内容给网站带来的流量,同时避免网站的权重被分流的危险。

四、使用Meta Noindex和follow tags

使用这种方法不仅可以防止被百度收录,还可以实现权重转移。当然具体怎么操作还要看站长的需求,但是使用这种方式屏蔽内容往往会浪费百度蜘蛛的抓取时间,从而影响优化体验,也就是说除非是不得已而为之。

对于一些站长用来屏蔽的表单模式和Javascript技术,已经不可能完成这个任务了,因为随着百度蜘蛛智能水平的提高,这些技术编辑的内容已经可以被抓取了,而且从不久的将来,一旦Flash中的内容可以被抓取,如果要屏蔽网站内容,也应该避免这种方法。

更多华旗商城产品介绍:自定义PHP网站构建婚纱摄影新模板中国山东网-枣庄软文写作技巧

网页新闻抓取(创建一个爬虫模板3.1创建crawlcrawl模板(注意在文件的根目录) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 257 次浏览 • 2022-03-23 04:19

)

1. 新项目

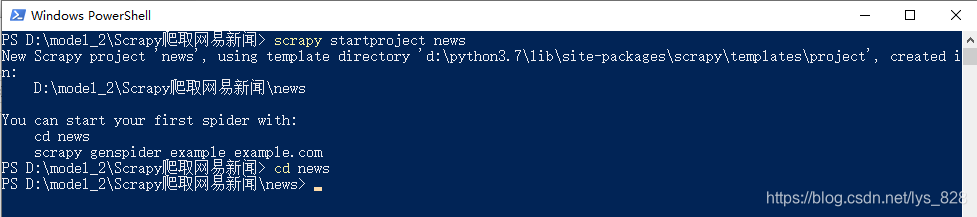

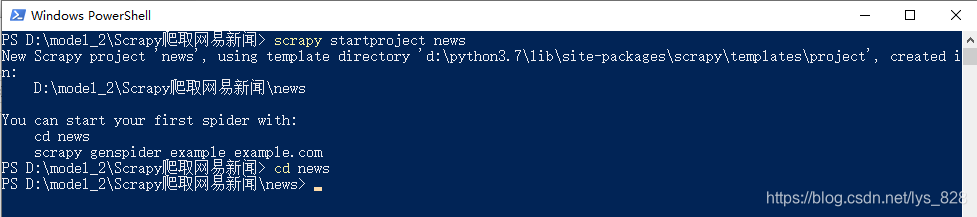

在命令行窗口输入scrapy startproject news,如下

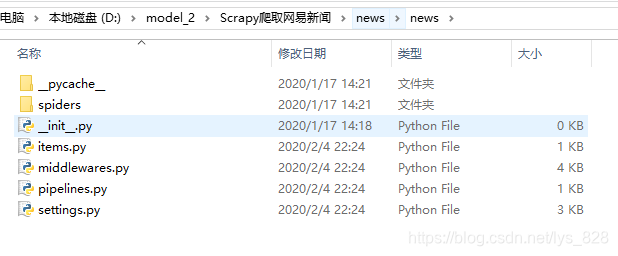

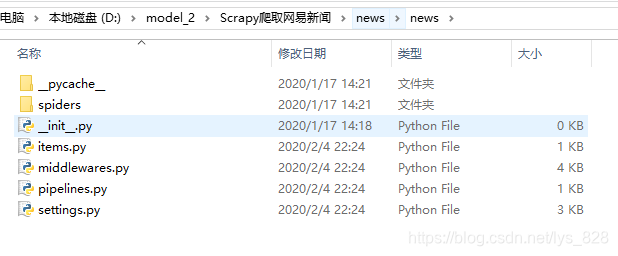

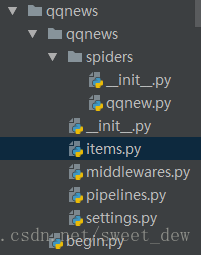

然后自动创建相应的文件,如下

关于各个文件的作用,上一篇博客有详细介绍,可以回看

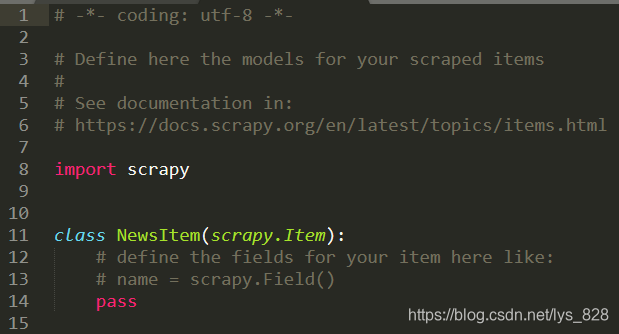

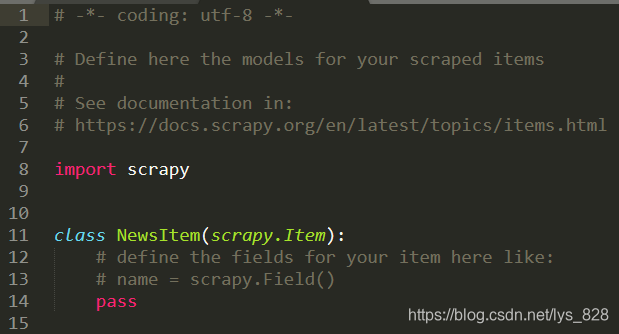

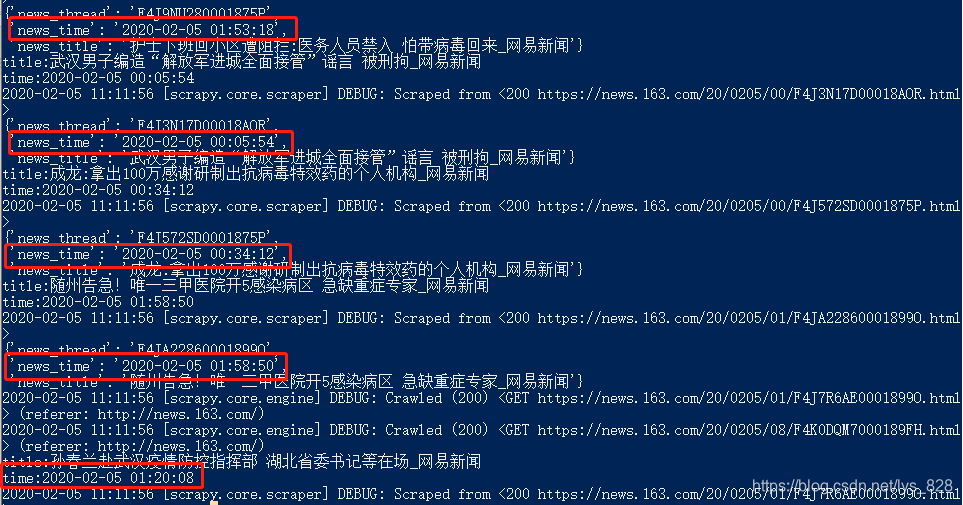

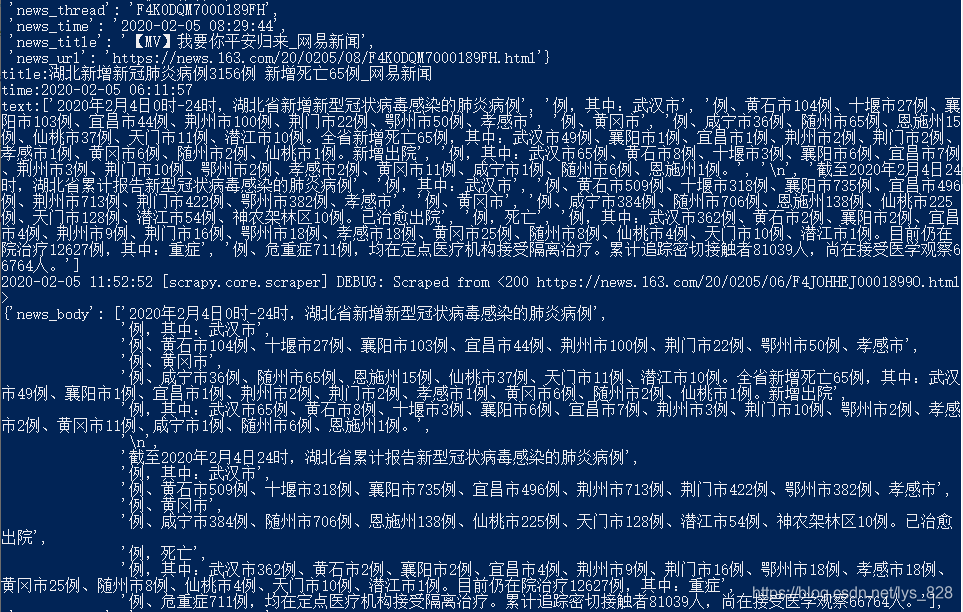

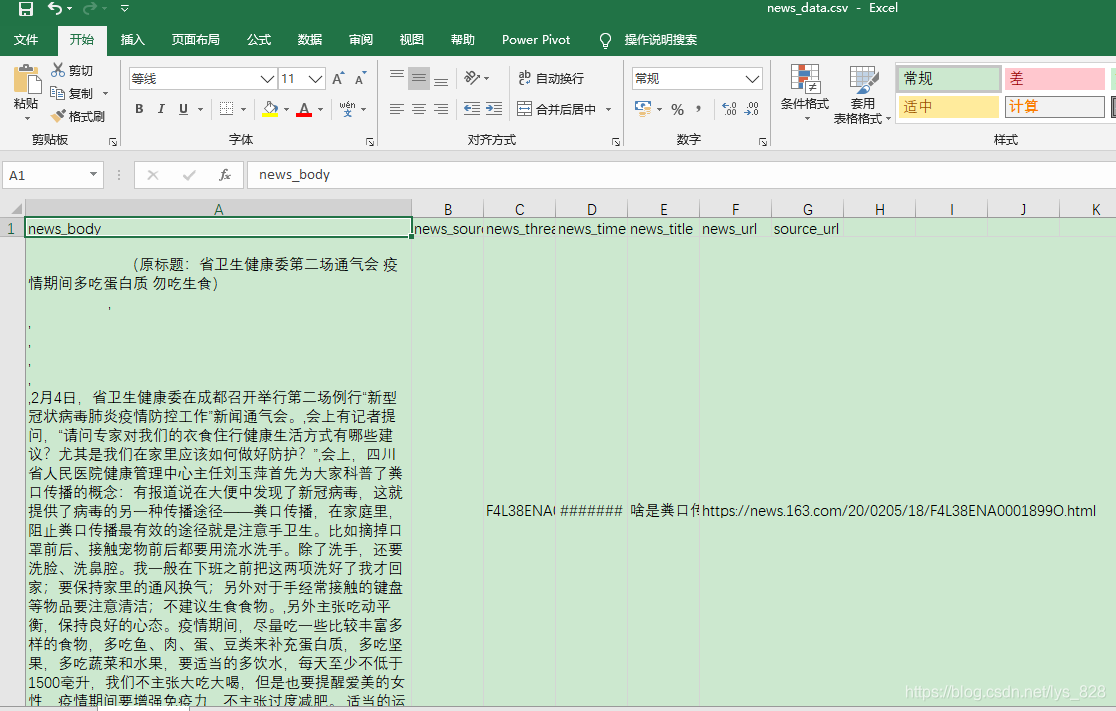

2. 修改itmes.py文件,打开scrapy框架自动创建的items.py文件,如下

在里面写代码,确定我要获取的信息,比如线程、新闻标题、url、时间、来源、来源url、新闻内容等。

import scrapy

class NewsItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

news_thread = scrapy.Field()

news_title = scrapy.Field()

news_url = scrapy.Field()

news_time = scrapy.Field()

news_source = scrapy.Field()

source_url = scrapy.Field()

news_body = scrapy.Field()

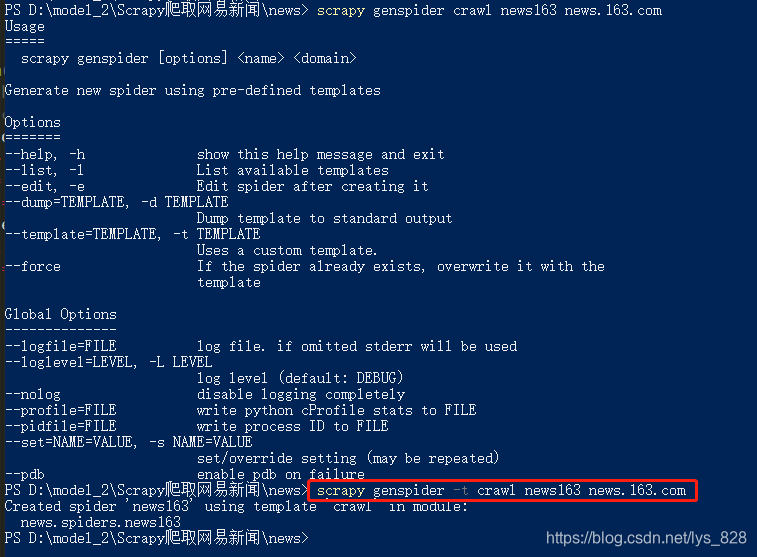

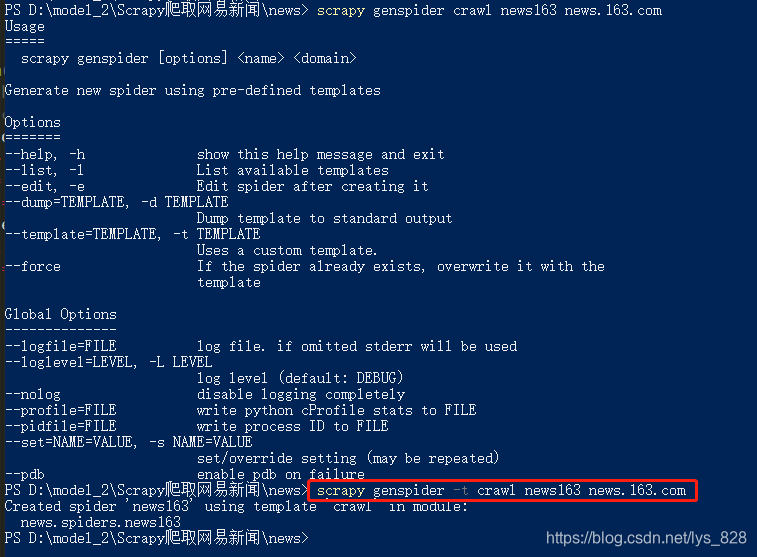

3.定义爬虫并创建爬虫模板3.1 创建爬虫爬虫模板

在命令行窗口下创建爬虫模板(注意文件根目录下,命令检查不要输入错误,-t表示使用下面的爬虫模板),会生成一个news163.py文件在spider文件夹中生成

然后看看这个‘爬取’模板和通用模板的区别。还有更多的链接提取器和一些爬虫规则,这将有助于我们爬取一些深入的信息。

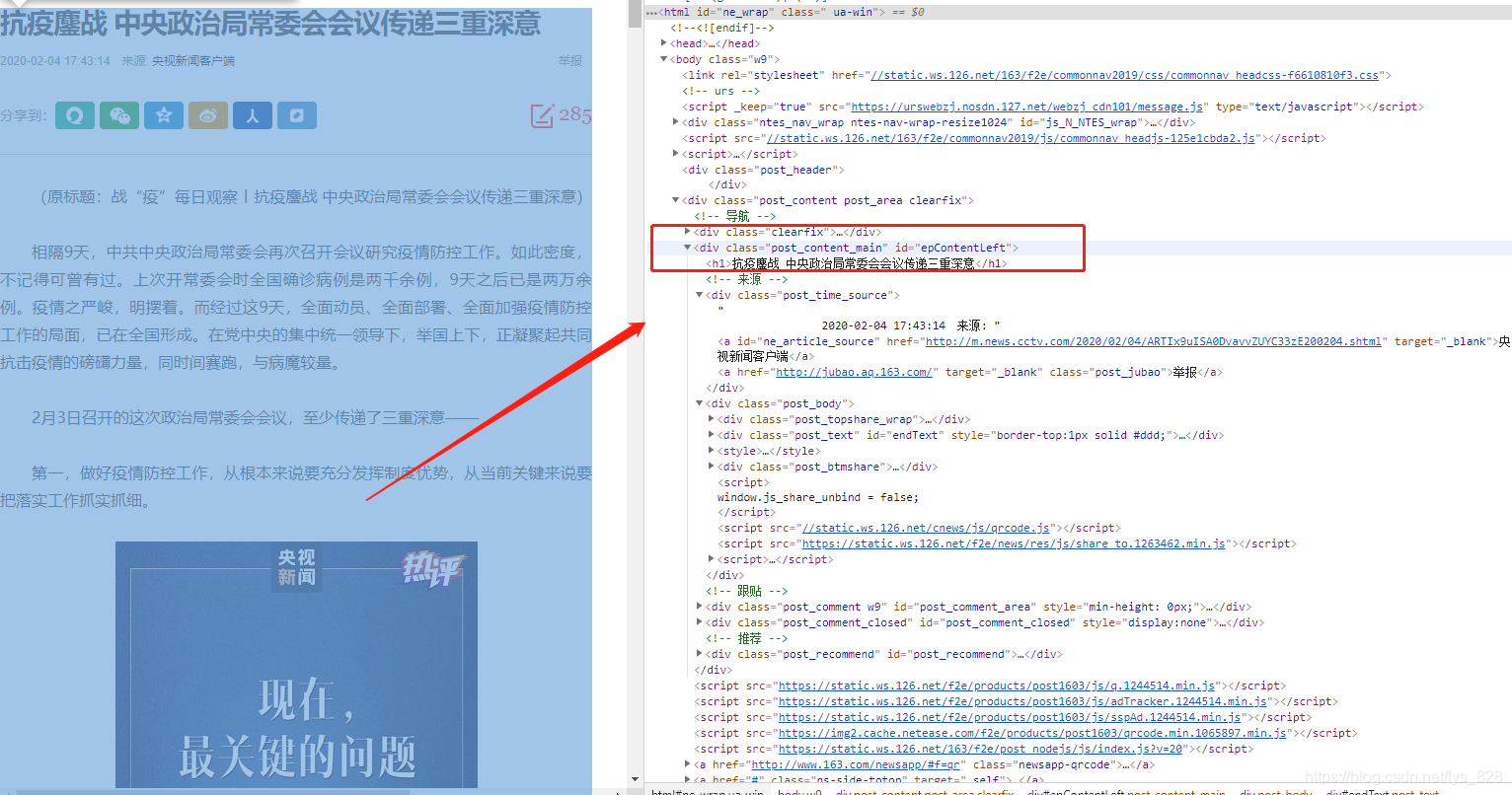

3.2 补充知识点:选择器选择器

支持xpath和css,在css选择器之前的爬虫案例中介绍过,这里是补充xpath的操作,xpath的语法如下

/html/head/标题

/html/head/title/text()

//td(两个用于深度提取/)

//div[@class='我的']

3.3. 分析网页内容

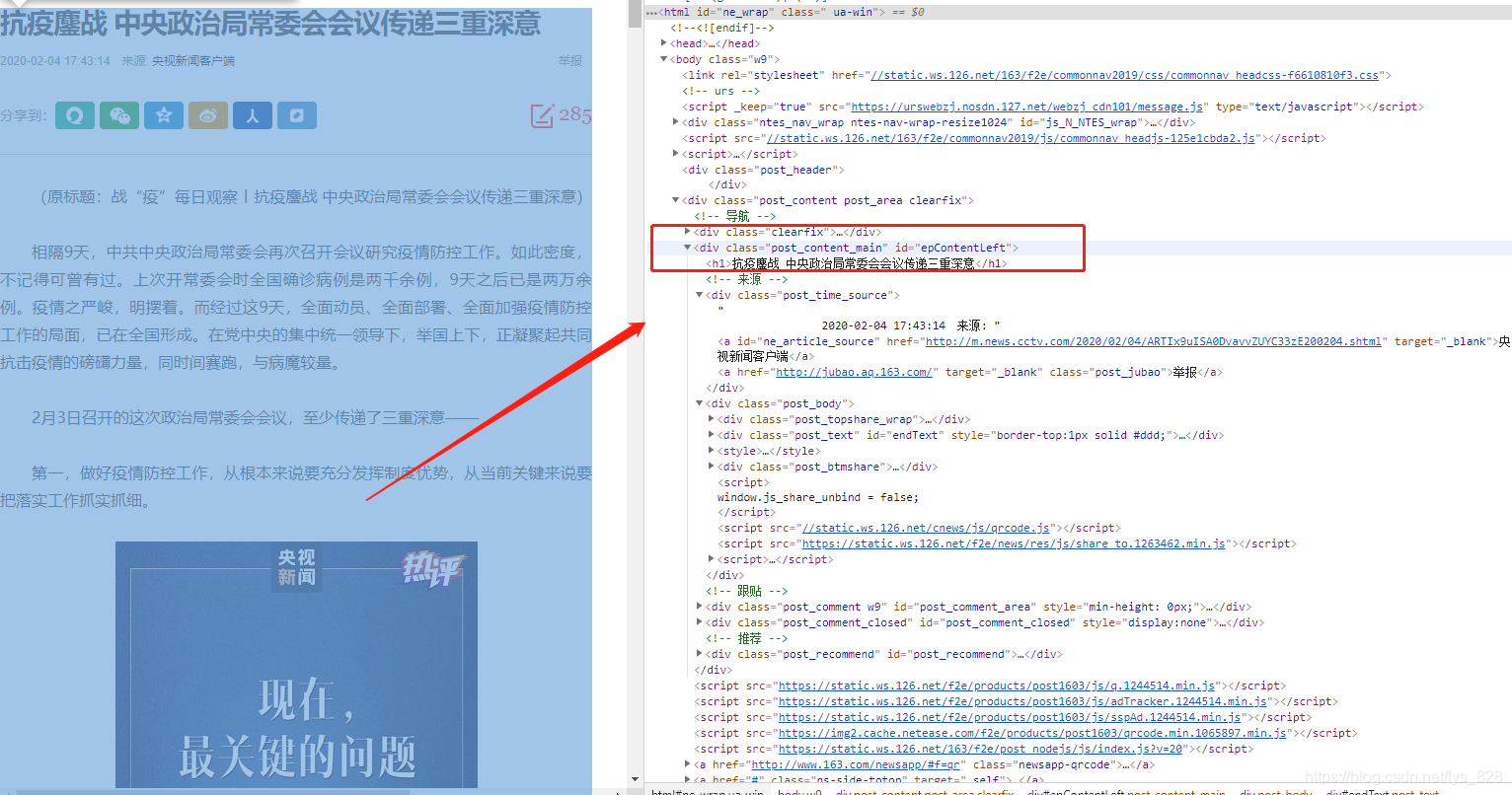

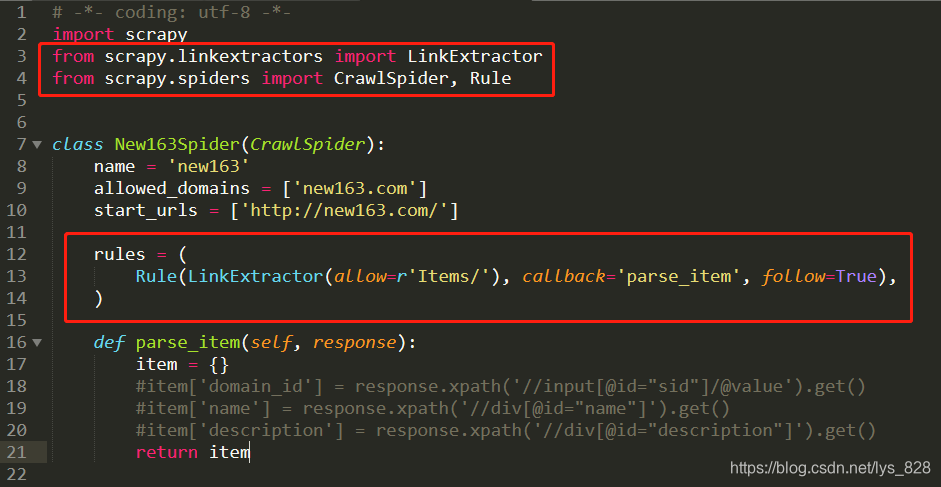

在谷歌chrome浏览器中输入Web News的网站,选择View Source Code,确认可以获取到itmes.py文件的内容(其实我们要获取的是查看源代码网页,然后确认可用)

确认title、time、url、source url和content都可以检查和匹配标签,比如body part

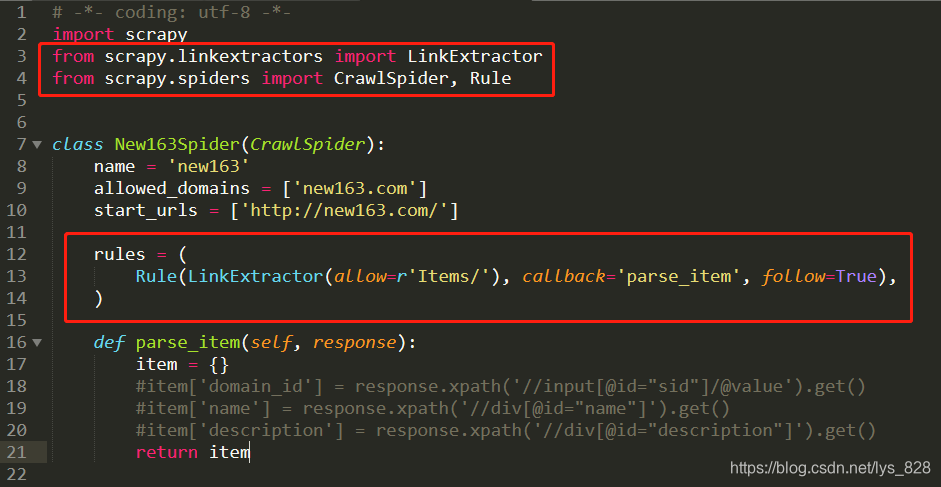

4.修改spider下创建的爬虫文件4.1 导入包

打开创建好的爬虫模板,编写代码。除了导入系统自动创建的三个库外,我们还需要导入news.items(这里涉及到包的概念,以及开头提到的--init-.py文件的存在说明这个文件夹是无需安装直接导入的包)

注意:使用的ExampleSpider类必须继承自CrawlSpider,因为一开始我们创建了一个'crawl'爬虫模板,对应上面

import scrapy

from news.items import NewsItem

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

class New163Spider(CrawlSpider):

name = 'new163'

allowed_domains = ['new163.com']

start_urls = ['http://new163.com/']

rules = (

Rule(LinkExtractor(allow=r'/18/04\d+/*'), callback='parse_news', follow=True),

)

def parse_item(self, response):

item = {}

#item['domain_id'] = response.xpath('//input[@id="sid"]/@value').get()

#item['name'] = response.xpath('//div[@id="name"]').get()

#item['description'] = response.xpath('//div[@id="description"]').get()

return item

Rule(LinkExtractor(allow=r'/18/04\d+/*'), callback='parse_news', follow=True),其中第一个允许是写正则表达式(也是我们需要在核心输入的) ,第二个是回调函数,第三个表示是否允许深

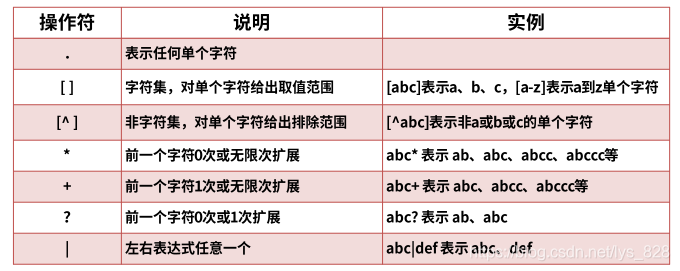

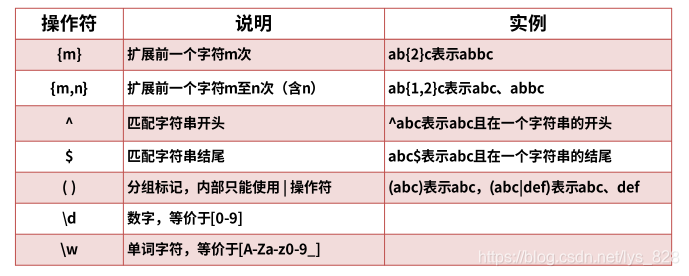

4.2 正则表达式简介

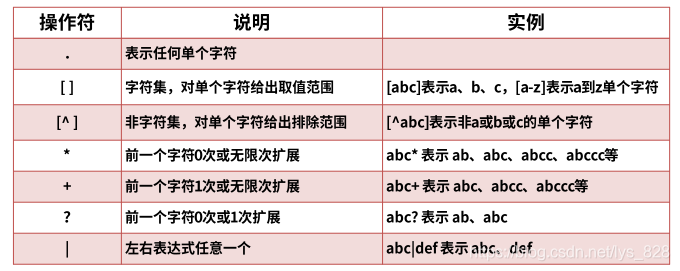

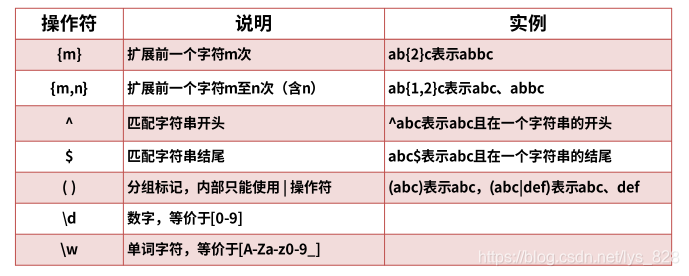

系统的介绍会在爬虫项目中讲解。以下是本项目可以用到的一些基础知识点。正则表达式由字符和运算符组成。常用语法如下

记住一个:“。*?” 是懒惰匹配,匹配只成功一次,可以解决大部分问题,有些需要自己写

比较新闻的标签,如下

第一条新闻的网址是:“”

第二条新闻的网址是:“”

…

规则可见,所以正则表达式可以写成如下

rules = (

Rule(LinkExtractor(allow=r'https://news.163.com/20/0204/\d+/.*?html'), callback='parse_item', follow=True),

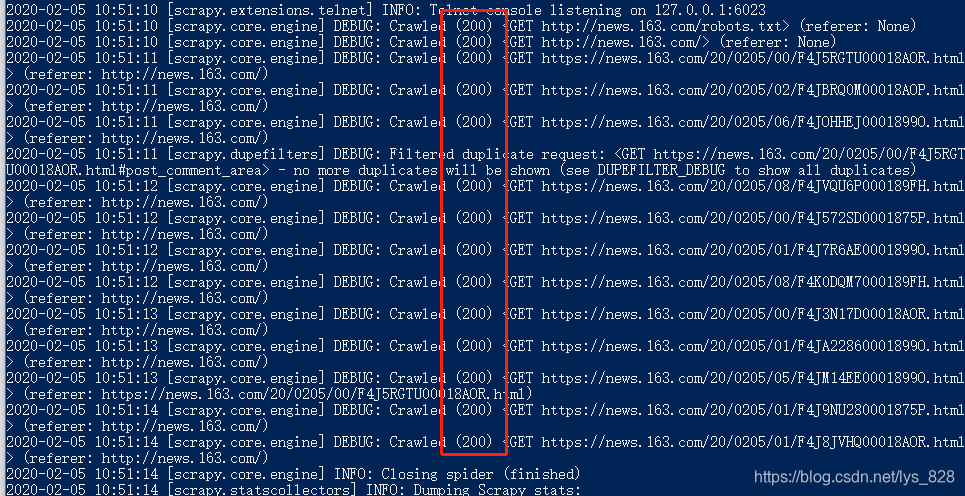

)

然后在命令行窗口运行命令:scrapy crawl news163

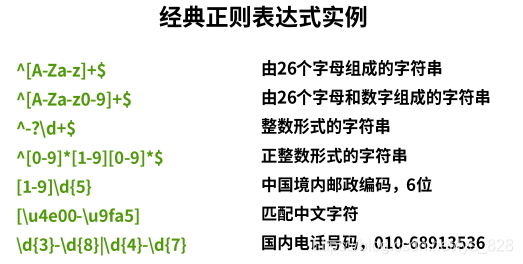

输出结果为:请求返回200,表示请求成功

4.3 回调函数

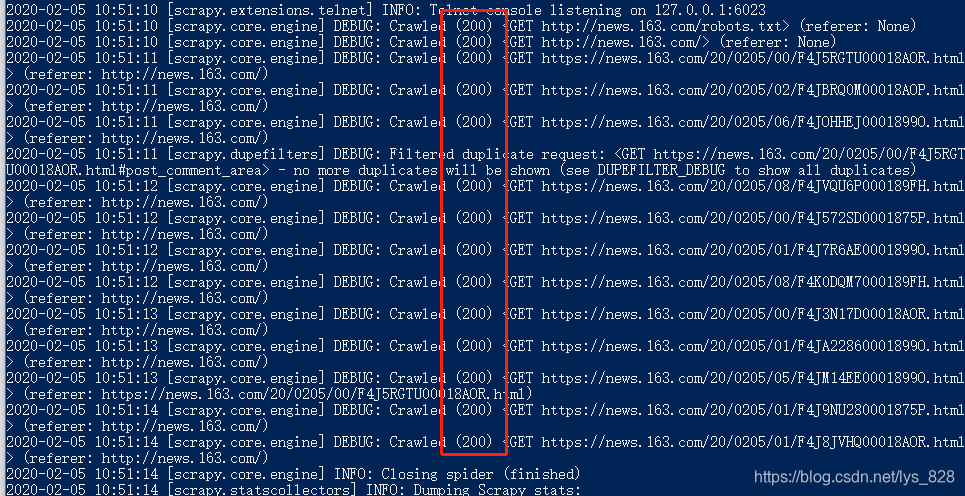

parse_item 是我们要设置的回调函数。首先我们处理两个比较简单的获取内容,get thread(去掉url最后五个字符的内容)和title(一般是网页源码的一个title标签中的内容),代码设置如下跟随

def parse_item(self, response):

item = NewsItem()

item['news_thread'] = response.url.strip().split("/")[-1][:-5]

self.get_title(response,item)

return item

def get_title(self,response,item):

title = response.css('title::text').extract()

if title:

print("title:{}".format(title[0]))

item['news_title'] = title[0]

保存后运行命令行窗口,输出如下

然后获取时间,在页面上选择check,在源码中找到新闻时间对应的标签信息,然后使用css选择器查找标签信息,如下

获取新闻时间的代码如下。时间后的内容是一种字符串处理的方法。目的是获取正常格式的时间数据。

self.get_time(response,item) #这个代码要放在回调函数里面

def get_time(self,response,item):

time = response.css('div.post_time_source::text').extract()

if time:

print('time:{}'.format(time[0].strip().replace("来源","").replace('\u3000:',"")))

item['news_time'] = time[0].strip().replace("来源","").replace('\u3000:',"")

输出是:

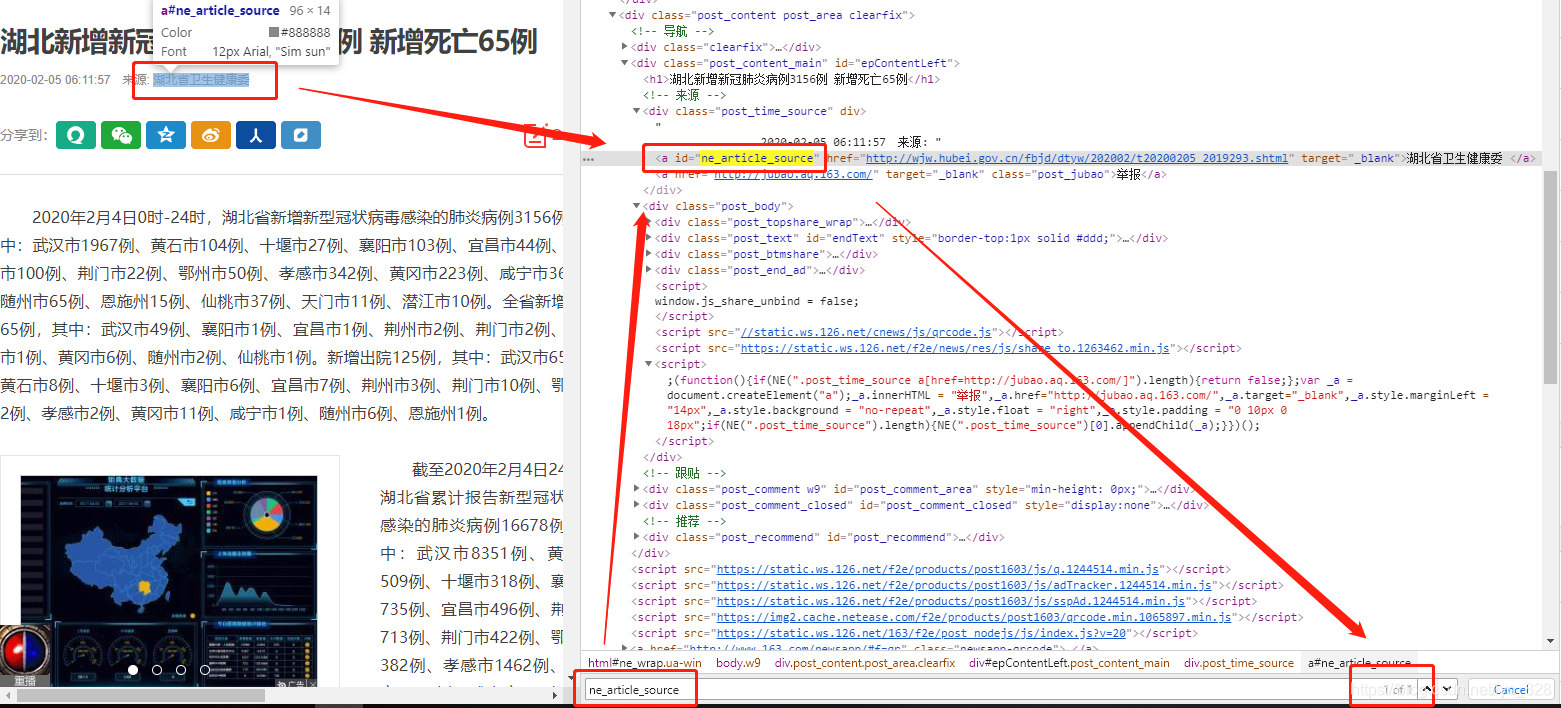

接下来获取新闻源,查看网页源码,发现新闻源在storage id标签下,可以直接搜索锁定标签(id只有一)

获取消息源的代码如下

self.get_source(response,item) #这个代码要放在回调函数里面

def get_source(self,response,item):

source = response.css("ne_article_source::text").extract()

if source:

print("source:{}".format(source[0]))

item['news_source'] = source[0]

获取原创新闻的URL的方式也差不多,这里直接上代码(注意这里不是id标签的文字内容,而是属性)

self.get_source_url(response,item)

def get_source_url(self,response,item):

source_url = response.css("ne_article_source::attr(href)").extract()

if source_url:

print("source_url:{}".format(source_url[0]))

item['source_url'] = source_url[0]

获取新闻内容,也可以直接给出参考代码如下

self.get_text(response,item)

def get_text(self,response,item):

text = response.css(".post_text p::text").extract()

if text:

print("text:{}".format(text))

item['news_body'] = text

获取新闻网址(原文),也直接给出参考代码如下

self.get_url(response,item)

def get_url(self,response,item):

url = response.url

if url:

item['news_url'] = url

至此,news163.py的所有代码编写如下:

import scrapy

from news.items import NewsItem

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

#https://news.163.com/20/0205/0 ... .html

#https://news.163.com/20/0205/0 ... .html

class News163Spider(CrawlSpider):

name = 'news163'

allowed_domains = ['news.163.com']

start_urls = ['http://news.163.com/']

rules = (

Rule(LinkExtractor(allow=r'https://news.163.com/20/0205/\d+/.*?html'), callback='parse_item', follow=True),

)

def parse_item(self, response):

item = NewsItem()

item['news_thread'] = response.url.strip().split("/")[-1][:-5]

self.get_title(response,item)

self.get_time(response,item)

self.get_source(response,item)

self.get_source_url(response,item)

self.get_text(response,item)

self.get_url(response,item)

return item

def get_url(self,response,item):

url = response.url

if url:

item['news_url'] = url

def get_text(self,response,item):

text = response.css(".post_text p::text").extract()

if text:

print("text:{}".format(text))

item['news_body'] = text

def get_source_url(self,response,item):

source_url = response.css("ne_article_source::attr(href)").extract()

if source_url:

#print("source_url:{}".format(source_url[0]))

item['source_url'] = source_url[0]

def get_source(self,response,item):

source = response.css("ne_article_source::text").extract()

if source:

print("source:{}".format(source[0]))

item['news_source'] = source[0]

def get_time(self,response,item):

time = response.css('div.post_time_source::text').extract()

if time:

print('time:{}'.format(time[0].strip().replace("来源","").replace('\u3000:',"")))

item['news_time'] = time[0].strip().replace("来源","").replace('\u3000:',"")

def get_title(self,response,item):

title = response.css('title::text').extract()

if title:

print("title:{}".format(title[0]))

item['news_title'] = title[0]

保存后运行命令行的输出如下(注意,注意,注意,调试过程中不要频繁运行此命令,否则会无法访问服务器),只会截取部分输出结果

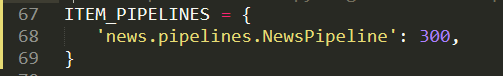

5.修改管道文件下的内容5.1 导入csv文件存储包

要在本地存储数据,需要一种格式作为存储的条件。逗号分隔(csv)文件可以满足这个要求,也是现在存储数据的主要工具。

from scrapy.exporters import CsvItemExporter

5.2 定义流程函数

首先从初始化函数开始,其中收录采集数据文件的创建和项目启动器

def __init__(self):

self.file = open('news_data.csv', 'wb')

self.exporter = CsvItemExporter(self.file, encoding = 'utf-8')

self.exporter.start_exporting()

二、定义爬虫终结者,完成项目,关闭进程和文件,防止内存溢出

def close_spider(self,spider):

self.exporter.finish_exporting()

self.file.close()

最后在处理函数中,打开import,最后返回Item

def process_item(self, item, spider):

self.exporter.export_item(item)

return item

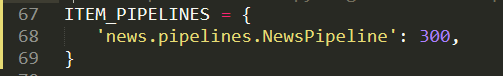

至此,管道中的代码编写已经完成。这时候需要在setting.py文件中打开管道通道,取消注释以下内容,如下

最后整个pipeline.py的文件代码如下,注意检查缩进问题(Sublime编辑器有一个选项可以将所有缩进转换成tab格式,保证缩进一致,注意缩进的问题网页编码,否则会出现乱码的情况,编码要根据爬取网页的编码格式设置)

from scrapy.exporters import CsvItemExporter

class NewsPipeline(object):

def __init__(self):

self.file = open('news_data.csv', 'wb')

self.exporter = CsvItemExporter(self.file, encoding = 'gbk')

self.exporter.start_exporting()

def close_spider(self,spider):

self.exporter.finish_exporting()

self.file.close()

def process_item(self, item, spider):

self.exporter.export_item(item)

return item

6. 运行结果

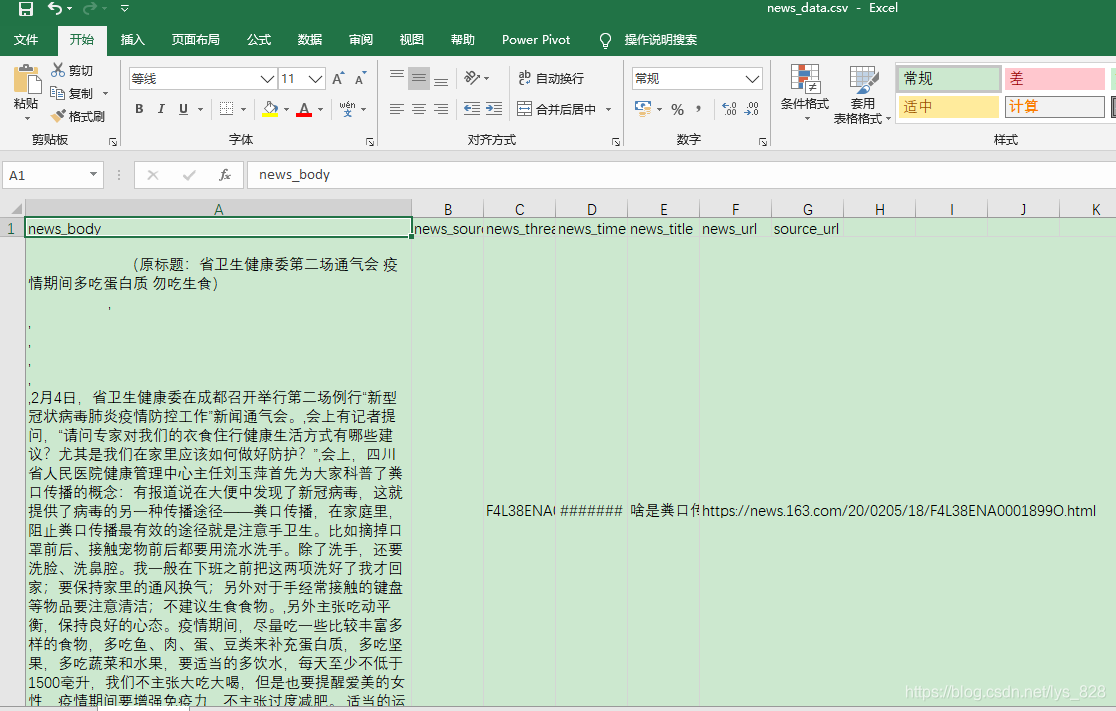

最后在命令行窗口中运行命令,当窗口界面出现爬取内容输出时,news文件夹中也自动生成了news_data.csv文件,如下

news_data.csv文件中的数据样式如下,至此整个使用Scrapy抓取网页新闻的项目全部结束

查看全部

网页新闻抓取(创建一个爬虫模板3.1创建crawlcrawl模板(注意在文件的根目录)

)

1. 新项目

在命令行窗口输入scrapy startproject news,如下

然后自动创建相应的文件,如下

关于各个文件的作用,上一篇博客有详细介绍,可以回看

2. 修改itmes.py文件,打开scrapy框架自动创建的items.py文件,如下

在里面写代码,确定我要获取的信息,比如线程、新闻标题、url、时间、来源、来源url、新闻内容等。

import scrapy

class NewsItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

news_thread = scrapy.Field()

news_title = scrapy.Field()

news_url = scrapy.Field()

news_time = scrapy.Field()

news_source = scrapy.Field()

source_url = scrapy.Field()

news_body = scrapy.Field()

3.定义爬虫并创建爬虫模板3.1 创建爬虫爬虫模板

在命令行窗口下创建爬虫模板(注意文件根目录下,命令检查不要输入错误,-t表示使用下面的爬虫模板),会生成一个news163.py文件在spider文件夹中生成

然后看看这个‘爬取’模板和通用模板的区别。还有更多的链接提取器和一些爬虫规则,这将有助于我们爬取一些深入的信息。

3.2 补充知识点:选择器选择器

支持xpath和css,在css选择器之前的爬虫案例中介绍过,这里是补充xpath的操作,xpath的语法如下

/html/head/标题

/html/head/title/text()

//td(两个用于深度提取/)

//div[@class='我的']

3.3. 分析网页内容

在谷歌chrome浏览器中输入Web News的网站,选择View Source Code,确认可以获取到itmes.py文件的内容(其实我们要获取的是查看源代码网页,然后确认可用)

确认title、time、url、source url和content都可以检查和匹配标签,比如body part

4.修改spider下创建的爬虫文件4.1 导入包

打开创建好的爬虫模板,编写代码。除了导入系统自动创建的三个库外,我们还需要导入news.items(这里涉及到包的概念,以及开头提到的--init-.py文件的存在说明这个文件夹是无需安装直接导入的包)

注意:使用的ExampleSpider类必须继承自CrawlSpider,因为一开始我们创建了一个'crawl'爬虫模板,对应上面

import scrapy

from news.items import NewsItem

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

class New163Spider(CrawlSpider):

name = 'new163'

allowed_domains = ['new163.com']

start_urls = ['http://new163.com/']

rules = (

Rule(LinkExtractor(allow=r'/18/04\d+/*'), callback='parse_news', follow=True),

)

def parse_item(self, response):

item = {}

#item['domain_id'] = response.xpath('//input[@id="sid"]/@value').get()

#item['name'] = response.xpath('//div[@id="name"]').get()

#item['description'] = response.xpath('//div[@id="description"]').get()

return item

Rule(LinkExtractor(allow=r'/18/04\d+/*'), callback='parse_news', follow=True),其中第一个允许是写正则表达式(也是我们需要在核心输入的) ,第二个是回调函数,第三个表示是否允许深

4.2 正则表达式简介

系统的介绍会在爬虫项目中讲解。以下是本项目可以用到的一些基础知识点。正则表达式由字符和运算符组成。常用语法如下

记住一个:“。*?” 是懒惰匹配,匹配只成功一次,可以解决大部分问题,有些需要自己写

比较新闻的标签,如下

第一条新闻的网址是:“”

第二条新闻的网址是:“”

…

规则可见,所以正则表达式可以写成如下

rules = (

Rule(LinkExtractor(allow=r'https://news.163.com/20/0204/\d+/.*?html'), callback='parse_item', follow=True),

)

然后在命令行窗口运行命令:scrapy crawl news163

输出结果为:请求返回200,表示请求成功

4.3 回调函数

parse_item 是我们要设置的回调函数。首先我们处理两个比较简单的获取内容,get thread(去掉url最后五个字符的内容)和title(一般是网页源码的一个title标签中的内容),代码设置如下跟随

def parse_item(self, response):

item = NewsItem()

item['news_thread'] = response.url.strip().split("/")[-1][:-5]

self.get_title(response,item)

return item

def get_title(self,response,item):

title = response.css('title::text').extract()

if title:

print("title:{}".format(title[0]))

item['news_title'] = title[0]

保存后运行命令行窗口,输出如下

然后获取时间,在页面上选择check,在源码中找到新闻时间对应的标签信息,然后使用css选择器查找标签信息,如下

获取新闻时间的代码如下。时间后的内容是一种字符串处理的方法。目的是获取正常格式的时间数据。

self.get_time(response,item) #这个代码要放在回调函数里面

def get_time(self,response,item):

time = response.css('div.post_time_source::text').extract()

if time:

print('time:{}'.format(time[0].strip().replace("来源","").replace('\u3000:',"")))

item['news_time'] = time[0].strip().replace("来源","").replace('\u3000:',"")

输出是:

接下来获取新闻源,查看网页源码,发现新闻源在storage id标签下,可以直接搜索锁定标签(id只有一)

获取消息源的代码如下

self.get_source(response,item) #这个代码要放在回调函数里面

def get_source(self,response,item):

source = response.css("ne_article_source::text").extract()

if source:

print("source:{}".format(source[0]))

item['news_source'] = source[0]

获取原创新闻的URL的方式也差不多,这里直接上代码(注意这里不是id标签的文字内容,而是属性)

self.get_source_url(response,item)

def get_source_url(self,response,item):

source_url = response.css("ne_article_source::attr(href)").extract()

if source_url:

print("source_url:{}".format(source_url[0]))

item['source_url'] = source_url[0]

获取新闻内容,也可以直接给出参考代码如下

self.get_text(response,item)

def get_text(self,response,item):

text = response.css(".post_text p::text").extract()

if text:

print("text:{}".format(text))

item['news_body'] = text

获取新闻网址(原文),也直接给出参考代码如下

self.get_url(response,item)

def get_url(self,response,item):

url = response.url

if url:

item['news_url'] = url

至此,news163.py的所有代码编写如下:

import scrapy

from news.items import NewsItem

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

#https://news.163.com/20/0205/0 ... .html

#https://news.163.com/20/0205/0 ... .html

class News163Spider(CrawlSpider):

name = 'news163'

allowed_domains = ['news.163.com']

start_urls = ['http://news.163.com/']

rules = (

Rule(LinkExtractor(allow=r'https://news.163.com/20/0205/\d+/.*?html'), callback='parse_item', follow=True),

)

def parse_item(self, response):

item = NewsItem()

item['news_thread'] = response.url.strip().split("/")[-1][:-5]

self.get_title(response,item)

self.get_time(response,item)

self.get_source(response,item)

self.get_source_url(response,item)

self.get_text(response,item)

self.get_url(response,item)

return item

def get_url(self,response,item):

url = response.url

if url:

item['news_url'] = url

def get_text(self,response,item):

text = response.css(".post_text p::text").extract()

if text:

print("text:{}".format(text))

item['news_body'] = text

def get_source_url(self,response,item):

source_url = response.css("ne_article_source::attr(href)").extract()

if source_url:

#print("source_url:{}".format(source_url[0]))

item['source_url'] = source_url[0]

def get_source(self,response,item):

source = response.css("ne_article_source::text").extract()

if source:

print("source:{}".format(source[0]))

item['news_source'] = source[0]

def get_time(self,response,item):

time = response.css('div.post_time_source::text').extract()

if time:

print('time:{}'.format(time[0].strip().replace("来源","").replace('\u3000:',"")))

item['news_time'] = time[0].strip().replace("来源","").replace('\u3000:',"")

def get_title(self,response,item):

title = response.css('title::text').extract()

if title:

print("title:{}".format(title[0]))

item['news_title'] = title[0]

保存后运行命令行的输出如下(注意,注意,注意,调试过程中不要频繁运行此命令,否则会无法访问服务器),只会截取部分输出结果

5.修改管道文件下的内容5.1 导入csv文件存储包

要在本地存储数据,需要一种格式作为存储的条件。逗号分隔(csv)文件可以满足这个要求,也是现在存储数据的主要工具。

from scrapy.exporters import CsvItemExporter

5.2 定义流程函数

首先从初始化函数开始,其中收录采集数据文件的创建和项目启动器

def __init__(self):

self.file = open('news_data.csv', 'wb')

self.exporter = CsvItemExporter(self.file, encoding = 'utf-8')

self.exporter.start_exporting()

二、定义爬虫终结者,完成项目,关闭进程和文件,防止内存溢出

def close_spider(self,spider):

self.exporter.finish_exporting()

self.file.close()

最后在处理函数中,打开import,最后返回Item

def process_item(self, item, spider):

self.exporter.export_item(item)

return item

至此,管道中的代码编写已经完成。这时候需要在setting.py文件中打开管道通道,取消注释以下内容,如下

最后整个pipeline.py的文件代码如下,注意检查缩进问题(Sublime编辑器有一个选项可以将所有缩进转换成tab格式,保证缩进一致,注意缩进的问题网页编码,否则会出现乱码的情况,编码要根据爬取网页的编码格式设置)

from scrapy.exporters import CsvItemExporter

class NewsPipeline(object):

def __init__(self):

self.file = open('news_data.csv', 'wb')

self.exporter = CsvItemExporter(self.file, encoding = 'gbk')

self.exporter.start_exporting()

def close_spider(self,spider):

self.exporter.finish_exporting()

self.file.close()

def process_item(self, item, spider):

self.exporter.export_item(item)

return item

6. 运行结果

最后在命令行窗口中运行命令,当窗口界面出现爬取内容输出时,news文件夹中也自动生成了news_data.csv文件,如下

news_data.csv文件中的数据样式如下,至此整个使用Scrapy抓取网页新闻的项目全部结束

网页新闻抓取(如何实现从各大网抓取新闻并解析网页的方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2022-03-21 18:34

如何从各大网络获取新闻,并通过格式处理现实给我们的新闻客户端?

我使用Android客户端抓取和解析网页的方法有两种:

一、使用jsoup

没仔细研究,网上也有类似的,可以参考这两位兄弟:

二、使用htmlparser

我在项目中使用htmlparser快速解析腾讯新闻,代码如下:

<p>1Java代码 收藏代码

2public class NetUtil {

3 public static List DATALIST = new ArrayList();

4

5 public static String[][] CHANNEL_URL = new String[][] {

6 new String[]{"http://news.qq.com/world_index.shtml","http://news.qq.com"},

7 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

8 new String[]{"http://news.qq.com/society_index.shtml","http://news.qq.com"},

9 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

10 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

11 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

12 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

13 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

14 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

15 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

16 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

17 };

18

19 public static int getTechNews(List techData, int cId) {

20 int result = 0;

21 try {

22 NodeFilter filter = new AndFilter(new TagNameFilter("div"),

23 new HasAttributeFilter("id", "listZone"));

24 Parser parser = new Parser();

25 parser.setURL(CHANNEL_URL[cId][0]);

26 parser.setEncoding(parser.getEncoding());

27

28 NodeList list = parser.extractAllNodesThatMatch(filter);

29 for (int i = 0; i 查看全部

网页新闻抓取(如何实现从各大网抓取新闻并解析网页的方法)

如何从各大网络获取新闻,并通过格式处理现实给我们的新闻客户端?

我使用Android客户端抓取和解析网页的方法有两种:

一、使用jsoup

没仔细研究,网上也有类似的,可以参考这两位兄弟:

二、使用htmlparser

我在项目中使用htmlparser快速解析腾讯新闻,代码如下:

<p>1Java代码 收藏代码

2public class NetUtil {

3 public static List DATALIST = new ArrayList();

4

5 public static String[][] CHANNEL_URL = new String[][] {

6 new String[]{"http://news.qq.com/world_index.shtml","http://news.qq.com"},

7 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

8 new String[]{"http://news.qq.com/society_index.shtml","http://news.qq.com"},

9 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

10 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

11 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

12 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

13 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

14 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

15 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

16 new String[]{"http://news.qq.com/china_index.shtml","http://news.qq.com"},

17 };

18

19 public static int getTechNews(List techData, int cId) {

20 int result = 0;

21 try {

22 NodeFilter filter = new AndFilter(new TagNameFilter("div"),

23 new HasAttributeFilter("id", "listZone"));

24 Parser parser = new Parser();

25 parser.setURL(CHANNEL_URL[cId][0]);

26 parser.setEncoding(parser.getEncoding());

27

28 NodeList list = parser.extractAllNodesThatMatch(filter);

29 for (int i = 0; i

网页新闻抓取(利用BeautifulSoup可以很简单的爬取网页上的内容。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 119 次浏览 • 2022-03-21 17:44

使用 BeautifulSoup,很容易爬取网络上的内容。这个工具包可以把网页变成DOM树

使用BeautifulSoup需要使用命令行安装,但也可以直接使用python ide。

基本操作:

①

使用前需要从bs4导入包:from bs4 import BeautifulSoup

②

使用的代码:soup = BeautifulSoup(res.text, 'html.parser')

括号中第一个参数的res是源网页,res.text是源网页的html,第二个参数'html.parser'是使用html的解析器。 ,

③

您可以使用select函数查找所有带有特定标签的HTML元素,例如:soup.select('h1') 查找所有收录h1标签的元素

它将返回一个列表,其中收录所有收录 'h1' 的元素。

以下是凤凰的一篇文章文章的简单爬取:

# coding=utf-8

from urllib import request, parse

from bs4 import BeautifulSoup

import re

#网页地址

url='http://news.ifeng.com/a/201811 ... 39%3B

#获取web网页

html=request.urlopen(url).read().decode('utf-8','ignore')

# 解析

soup=BeautifulSoup(html,'html.parser')

# 获取信息

page=soup.find('div',{'id':'artical'})

#根据所要爬取内容提取网页中的CSS元素,如标题及内容

page_topic=page.find('h1',id='artical_topic')

#使用text属性,提取标题和文本内容

topic=page_topic.get_text()

content=''

content=content+topic

page_content = page.find('div',id='main_content')

# contents=page_content.select('p')

for p in page_content.select('p'):

content=content+p.get_text()

# print(topic)

# print('\r')

print(content)

这样就可以实现一个简单的网络新闻抓取 查看全部

网页新闻抓取(利用BeautifulSoup可以很简单的爬取网页上的内容。)

使用 BeautifulSoup,很容易爬取网络上的内容。这个工具包可以把网页变成DOM树

使用BeautifulSoup需要使用命令行安装,但也可以直接使用python ide。

基本操作:

①

使用前需要从bs4导入包:from bs4 import BeautifulSoup

②

使用的代码:soup = BeautifulSoup(res.text, 'html.parser')

括号中第一个参数的res是源网页,res.text是源网页的html,第二个参数'html.parser'是使用html的解析器。 ,

③

您可以使用select函数查找所有带有特定标签的HTML元素,例如:soup.select('h1') 查找所有收录h1标签的元素

它将返回一个列表,其中收录所有收录 'h1' 的元素。

以下是凤凰的一篇文章文章的简单爬取:

# coding=utf-8

from urllib import request, parse

from bs4 import BeautifulSoup

import re

#网页地址

url='http://news.ifeng.com/a/201811 ... 39%3B

#获取web网页

html=request.urlopen(url).read().decode('utf-8','ignore')

# 解析

soup=BeautifulSoup(html,'html.parser')

# 获取信息

page=soup.find('div',{'id':'artical'})

#根据所要爬取内容提取网页中的CSS元素,如标题及内容

page_topic=page.find('h1',id='artical_topic')

#使用text属性,提取标题和文本内容

topic=page_topic.get_text()

content=''

content=content+topic

page_content = page.find('div',id='main_content')

# contents=page_content.select('p')

for p in page_content.select('p'):

content=content+p.get_text()

# print(topic)

# print('\r')

print(content)

这样就可以实现一个简单的网络新闻抓取

网页新闻抓取(2.1.2dataflow数据的flow,由执行的engine,步骤)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-03-21 12:04

2.1.2数据流

数据流由执行引擎控制,如图中的各个步骤所示。

* Step1:scrapy引擎首先获取初始化的URL(Requests)。

* Step2:然后交给Scheduler调度Requests,请求下一个URL。

* Step3:调度器将下一个请求返回给scrapy引擎

* Step4:scrapy引擎通过Downloader Middlewares(process_request())向Downloader发送请求。

* Step5:Downloader Middlewares完成网页下载后,会生成一个Response并通过Downloader Middlewares发送回scrapy引擎(process_response())。

* Step6:scrapy引擎收到Response后,会通过Spider Middlewares发送给Spider做进一步处理。

* Step7:Spider在处理完Response后会将抓取的item和新的Requests(链接在下一页)返回给scrapy引擎。

* Step8:crapy引擎将处理后的item发送到Item Pipelines,然后将Requests发送回Scheduler,请求下一个可能的URL进行爬取。

* Step9:从step1开始重复上述操作,直到Scheduler中没有多余的URL请求为止

提示:解释第 7 步

Spider分析的结果有两种:

* 一种是针对需要进一步爬取的链接,比如“下一页”链接,会发回Scheduler;

* 另一个是需要保存的数据,发送到Item Pipeline进行后期处理(详细分析、过滤、存储等)。

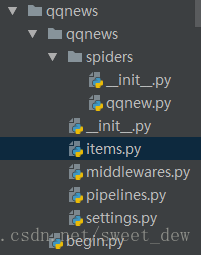

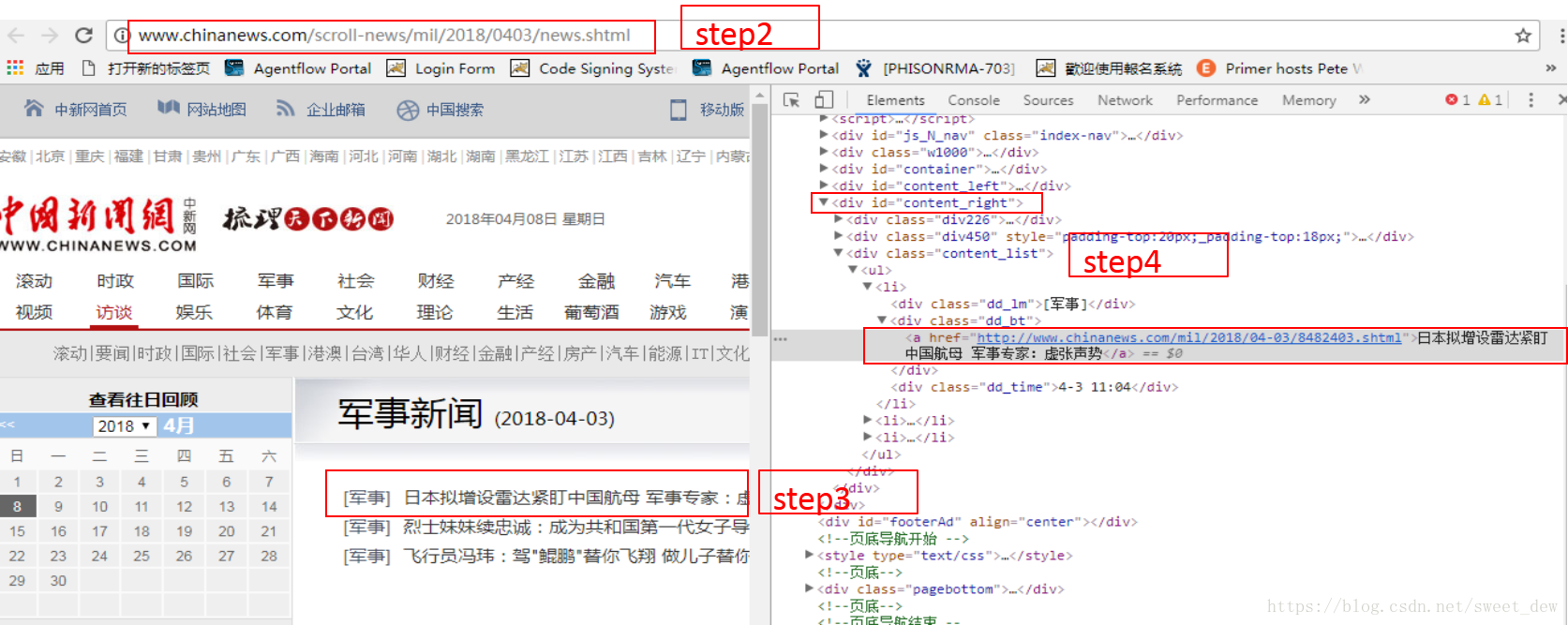

2.1.3 爬取过程第三部分,爬取中国新闻网半年的各类新闻

我的环境是Python3.6+Scrapy,Windows,IDE:PyCharm

3.1 创建一个新的scrapy项目**

在命令行输入scrapy startproject qqnews

会出现以下文件

3.1.1个qqnew.py来写我们的主要爬取代码**

首先我们需要导入对应的文件

from scrapy.spiders import Spider

from qqnews.items import QqnewsItem

spider会自动从start_urls抓取网页,可以收录多个url。

并且会默认调用parse函数,parse是蜘蛛抓取网页时的默认调用回调。

提示:因为我们要抓新闻半年的数据,先通过start_urls获取半年每个月的url,观察url的规律。比如下面这两天的URL就很容易看出规律了,

我们可以通过拼接字符串来抓取每一天的网址

* 每天:

* 每个月:

代码中最后一句是scrapy.Request(url_month,callback=self.parse_month)生成的

* url_month: 是解析拼接后要抓取的每一天的url

* callback=self.parse_month:这句话的意思是每天的url都会调用自定义的parse_month来解析每天网页的内容

class QQNewsSpider(Spider):

name = 'qqnews'

start_urls=[#'http://www.chinanews.com/society.shtml',

#'http://www.chinanews.com/mil/news.shtml',

'http://finance.chinanews.com/it/gd.shtml',

]

def parse(self,response):

#找到所有连接的入口,一条一条的新闻做解析 //*[@id="news"] //*[@id="news"]/div[2]/div[1]/div[1]/em/a

for month in range(1,8):

for day in range(1,31):

if month is 2 and day>28 :

continue

elif month is 7 and day>6:

continue

else:

if day in range(1,10):

url_month='http://www.chinanews.com/scrol ... 2Bstr(month)+'0'+str(day)+'/news.shtml'

else:

url_month='http://www.chinanews.com/scrol ... 2Bstr(month)+str(day)+'/news.shtml'

yield scrapy.Request(url_month,callback=self.parse_month)

我们已经从前面的代码中获得了每天新闻对应的链接URL,接下来我们应该抓取对应页面的新闻标题和新闻内容。

即自定义def parse_month(self,response)处理的内容。

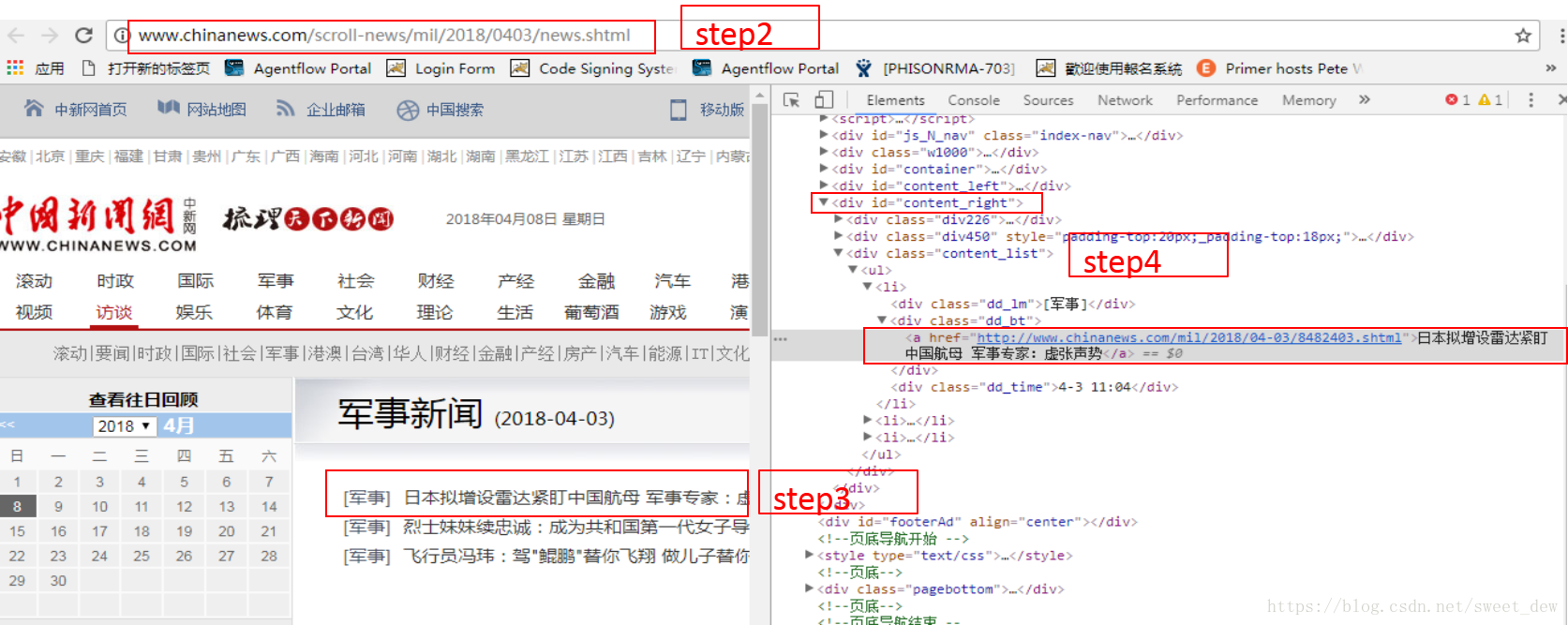

用chrome浏览器右键“查看”,找到对应的每日新闻头条

scrapy 提供了一种方便的方式来解析网页中的数据,而 文章 中使用 Xpath 进行解析。

提示:

* //ul/li 表示选择ul标签下的所有li标签

* a/@href 表示选择所有a标签的href属性

* a/text() 表示选择一个标签文本

* div[@id="content_right"] 表示选择id属性为content_right的所有div标签

def parse_month(self,response):

#print(response.body)

#到了没一个月的页面下,提取每一天的url

urls=response.xpath('//div[@id="content_right"]/div[@class="content_list"]/ul/li/div[@class="dd_bt"]/a/@href').extract()

for url in urls:

yield scrapy.Request(url,callback=self.parse_news)

找到新闻头条对应的新闻内容URL后,就可以抓取每日新闻头条和对应的新闻内容了。

然后通过 self.parse_news,

存储标题和内容,这是我们第一次导入时使用的item=QqnewsItem()

def parse_news(self,response):

item=QqnewsItem()

item['title']=response.xpath('//div[@class="con_left"]/div[@id="cont_1_1_2"]/h1/text()').extract()

item['text']='\n'.join(response.xpath('//div[@class="left_zw"]/p/text()').extract())

yield item

在 items.py 中添加一些类

class QqnewsItem(scrapy.Item):

# define the fields for your item here like:

text=scrapy.Field()#新闻的内容

title=scrapy.Field()#新闻的标题

最后,如果要将抓取的内容保存到文件中,可以新建一个begin.py,直接执行下面这句话。

在 begin.py 中

from scrapy import cmdline

cmdline.execute("scrapy crawl qqnews -o IT.csv".split())

然后我们可以根据fastText将爬取的数据处理成fastText格式,然后直接训练。

参考文献文章: 查看全部

网页新闻抓取(2.1.2dataflow数据的flow,由执行的engine,步骤)

2.1.2数据流

数据流由执行引擎控制,如图中的各个步骤所示。

* Step1:scrapy引擎首先获取初始化的URL(Requests)。

* Step2:然后交给Scheduler调度Requests,请求下一个URL。

* Step3:调度器将下一个请求返回给scrapy引擎

* Step4:scrapy引擎通过Downloader Middlewares(process_request())向Downloader发送请求。

* Step5:Downloader Middlewares完成网页下载后,会生成一个Response并通过Downloader Middlewares发送回scrapy引擎(process_response())。

* Step6:scrapy引擎收到Response后,会通过Spider Middlewares发送给Spider做进一步处理。

* Step7:Spider在处理完Response后会将抓取的item和新的Requests(链接在下一页)返回给scrapy引擎。

* Step8:crapy引擎将处理后的item发送到Item Pipelines,然后将Requests发送回Scheduler,请求下一个可能的URL进行爬取。

* Step9:从step1开始重复上述操作,直到Scheduler中没有多余的URL请求为止

提示:解释第 7 步

Spider分析的结果有两种:

* 一种是针对需要进一步爬取的链接,比如“下一页”链接,会发回Scheduler;

* 另一个是需要保存的数据,发送到Item Pipeline进行后期处理(详细分析、过滤、存储等)。

2.1.3 爬取过程第三部分,爬取中国新闻网半年的各类新闻

我的环境是Python3.6+Scrapy,Windows,IDE:PyCharm

3.1 创建一个新的scrapy项目**

在命令行输入scrapy startproject qqnews

会出现以下文件

3.1.1个qqnew.py来写我们的主要爬取代码**

首先我们需要导入对应的文件

from scrapy.spiders import Spider

from qqnews.items import QqnewsItem

spider会自动从start_urls抓取网页,可以收录多个url。

并且会默认调用parse函数,parse是蜘蛛抓取网页时的默认调用回调。

提示:因为我们要抓新闻半年的数据,先通过start_urls获取半年每个月的url,观察url的规律。比如下面这两天的URL就很容易看出规律了,

我们可以通过拼接字符串来抓取每一天的网址

* 每天:

* 每个月:

代码中最后一句是scrapy.Request(url_month,callback=self.parse_month)生成的

* url_month: 是解析拼接后要抓取的每一天的url

* callback=self.parse_month:这句话的意思是每天的url都会调用自定义的parse_month来解析每天网页的内容

class QQNewsSpider(Spider):

name = 'qqnews'

start_urls=[#'http://www.chinanews.com/society.shtml',

#'http://www.chinanews.com/mil/news.shtml',

'http://finance.chinanews.com/it/gd.shtml',

]

def parse(self,response):

#找到所有连接的入口,一条一条的新闻做解析 //*[@id="news"] //*[@id="news"]/div[2]/div[1]/div[1]/em/a

for month in range(1,8):

for day in range(1,31):

if month is 2 and day>28 :

continue

elif month is 7 and day>6:

continue

else:

if day in range(1,10):

url_month='http://www.chinanews.com/scrol ... 2Bstr(month)+'0'+str(day)+'/news.shtml'

else:

url_month='http://www.chinanews.com/scrol ... 2Bstr(month)+str(day)+'/news.shtml'

yield scrapy.Request(url_month,callback=self.parse_month)

我们已经从前面的代码中获得了每天新闻对应的链接URL,接下来我们应该抓取对应页面的新闻标题和新闻内容。

即自定义def parse_month(self,response)处理的内容。

用chrome浏览器右键“查看”,找到对应的每日新闻头条

scrapy 提供了一种方便的方式来解析网页中的数据,而 文章 中使用 Xpath 进行解析。

提示:

* //ul/li 表示选择ul标签下的所有li标签

* a/@href 表示选择所有a标签的href属性

* a/text() 表示选择一个标签文本

* div[@id="content_right"] 表示选择id属性为content_right的所有div标签

def parse_month(self,response):

#print(response.body)

#到了没一个月的页面下,提取每一天的url

urls=response.xpath('//div[@id="content_right"]/div[@class="content_list"]/ul/li/div[@class="dd_bt"]/a/@href').extract()

for url in urls:

yield scrapy.Request(url,callback=self.parse_news)

找到新闻头条对应的新闻内容URL后,就可以抓取每日新闻头条和对应的新闻内容了。

然后通过 self.parse_news,

存储标题和内容,这是我们第一次导入时使用的item=QqnewsItem()

def parse_news(self,response):

item=QqnewsItem()

item['title']=response.xpath('//div[@class="con_left"]/div[@id="cont_1_1_2"]/h1/text()').extract()

item['text']='\n'.join(response.xpath('//div[@class="left_zw"]/p/text()').extract())

yield item

在 items.py 中添加一些类

class QqnewsItem(scrapy.Item):

# define the fields for your item here like:

text=scrapy.Field()#新闻的内容

title=scrapy.Field()#新闻的标题

最后,如果要将抓取的内容保存到文件中,可以新建一个begin.py,直接执行下面这句话。

在 begin.py 中

from scrapy import cmdline

cmdline.execute("scrapy crawl qqnews -o IT.csv".split())

然后我们可以根据fastText将爬取的数据处理成fastText格式,然后直接训练。

参考文献文章:

网页新闻抓取(采用AJAX技术的网站越来越多,我们有必要通过更多案例讲解)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-03-18 13:34

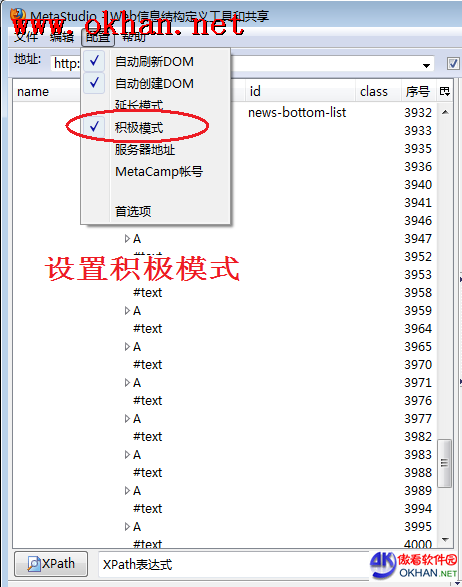

越来越多的网站在使用AJAX技术,我们有必要通过更多的案例来说明如何准确捕捉Javascript/JS动态生成的内容。这次我们要在cnbeta网站上抓取数字产品新闻。进入这个网站的首页,可以看到一个新闻列表,列表中有多条新闻,每条包括标题、基本信息和摘要。用浏览器访问这个网页,发现新闻列表的第一页和普通网页一样。翻到第二页后,使用浏览器的查看源代码功能,无论现在看到哪个页面,都可以看到HTML源代码没有变化。分页,HTML源代码仍然是第一页。原来 网站 翻页时应使用Javascript动态刷新新闻列表。这种情况会阻碍普通网络爬虫和普通网络爬虫的工作,因为这类网络爬虫一般会向目标服务器发送HTTP GET。消息,获取 HTML 文档,然后使用正则表达式或 DOM 解析方法提取网页上的内容。当需要跳转到其他页面时,由于其他页面没有独立的URL网址,无法发送HTTP GET消息,只能通过人工干预,嗅探Javascript发送给网站的消息是什么,通过获取其他分页内容模拟消息。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。这种情况会阻碍普通网络爬虫和普通网络爬虫的工作,因为这类网络爬虫一般会向目标服务器发送HTTP GET。消息,获取 HTML 文档,然后使用正则表达式或 DOM 解析方法提取网页上的内容。当需要跳转到其他页面时,由于其他页面没有独立的URL网址,无法发送HTTP GET消息,只能通过人工干预,嗅探Javascript发送给网站的消息是什么,通过获取其他分页内容模拟消息。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。这种情况会阻碍普通网络爬虫和普通网络爬虫的工作,因为这类网络爬虫一般会向目标服务器发送HTTP GET。消息,获取 HTML 文档,然后使用正则表达式或 DOM 解析方法提取网页上的内容。当需要跳转到其他页面时,由于其他页面没有独立的URL网址,无法发送HTTP GET消息,只能通过人工干预,嗅探Javascript发送给网站的消息是什么,通过获取其他分页内容模拟消息。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。获取 HTML 文档,然后使用正则表达式或 DOM 解析方法提取网页上的内容。当需要跳转到其他页面时,由于其他页面没有独立的URL网址,无法发送HTTP GET消息,只能通过人工干预,嗅探Javascript发送给网站的消息是什么,通过获取其他分页内容模拟消息。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。获取 HTML 文档,然后使用正则表达式或 DOM 解析方法提取网页上的内容。当需要跳转到其他页面时,由于其他页面没有独立的URL网址,无法发送HTTP GET消息,只能通过人工干预,嗅探Javascript发送给网站的消息是什么,通过获取其他分页内容模拟消息。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。嗅探 Javascript 发送给 网站 的消息,并通过模拟消息获取其他分页内容。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。嗅探 Javascript 发送给 网站 的消息,并通过模拟消息获取其他分页内容。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。

本文还将讲解另一种爬取技巧:在翻转新闻列表时,假设某个页面中的新闻之前已经被爬取过,停止向下翻页,即只抓取最新的新闻。它是追踪论坛、博客、微博、新闻网站等最常用的技术,也是构建企业竞争情报系统必不可少的功能。

爬取目标分析:

翻转和抓取多个页面。之前爬取二级URL时,停止爬取进程

注1:可以使用MetaStudio加载信息结构demo_cnbeta_list,阅读起来比较容易理解。请注意,着陆页的结构可能会发生变化,这可能会导致信息结构加载不成功。请参考“修改无效信息结构”修改信息结构。

注意 2:本文不是介绍性教程。如果您对 MetaSeeker 不熟悉,建议按照章节顺序阅读《MetaSeeker 崩溃手册》。

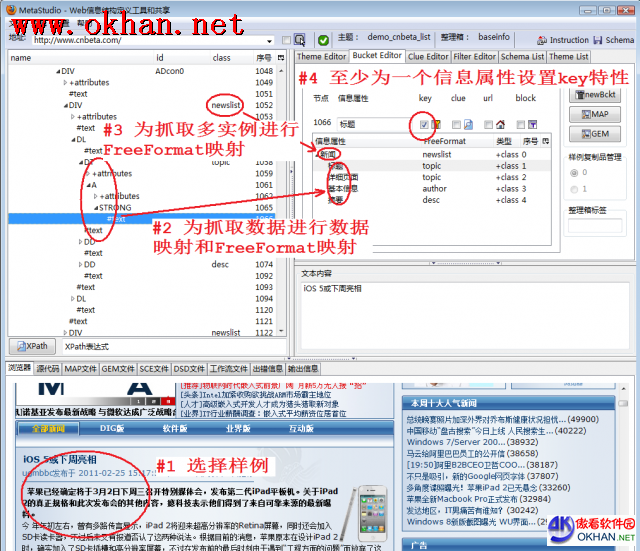

1 获取新闻摘要数据

ͼ1

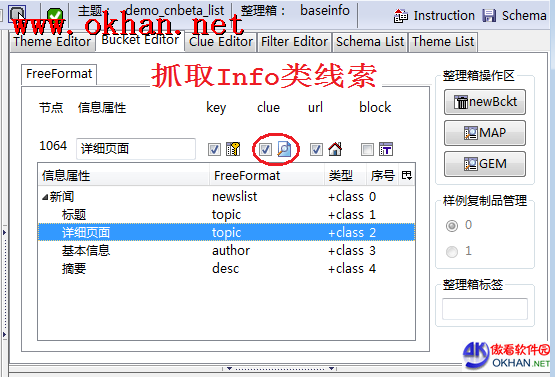

首先,需要定义数据抓取规则。所谓数据抓取规则,就是指定如何从网页中抓取新闻列表数据。图1展示了数据映射和FreeFormat映射的过程,主要包括以下步骤:

以新闻列表中的第一条新闻为例,对其进行数据映射和FreeFormat映射。为了获取新闻数据,需要进行数据映射和FreeFormat映射,其中FreeFormat映射不是必须的,如果网页具有表示DOM节点的语义,可以使用@class或@id属性来精确定位被抓取的内容,然后执行 FreeFormat 映射。详细操作流程请参考《捕捉京东商品价格》。为了捕捉新闻列表中的每一条新闻,都要进行FreeFormat映射,也就是所谓的多实例捕捉。FreeFormat映射不是唯一的方法,这个页面的每条新闻都有@class="newslist",非常适合爬取多个实例。如果没有合适的 FreeFormat,您可以使用示例复制方法。请参考“捕获当当商品价格”设置至少一个信息属性的关键属性。关键属性的描述请参考《MetaStudio 用户手册》。设置关键特性后,DataScraper 可以运行在加速模式,提高爬取速度。如果DataScraper菜单项“Configuration”->“Normal Mode”没有勾选,DataScraper进入加速模式。

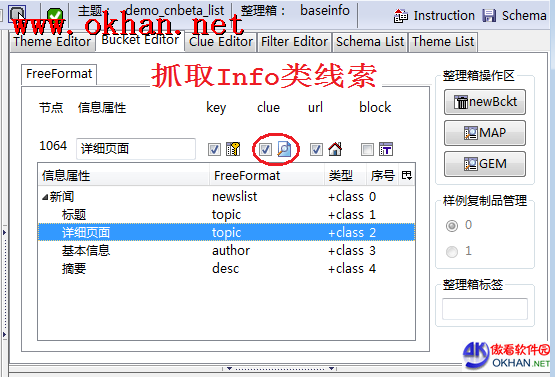

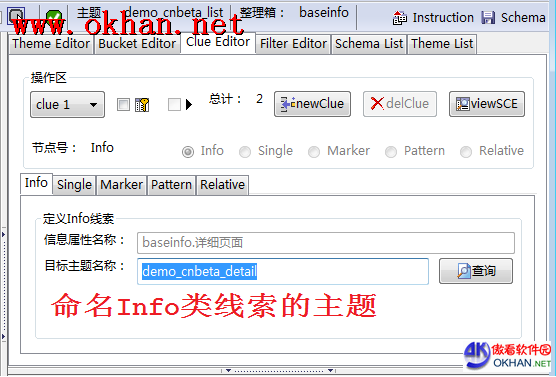

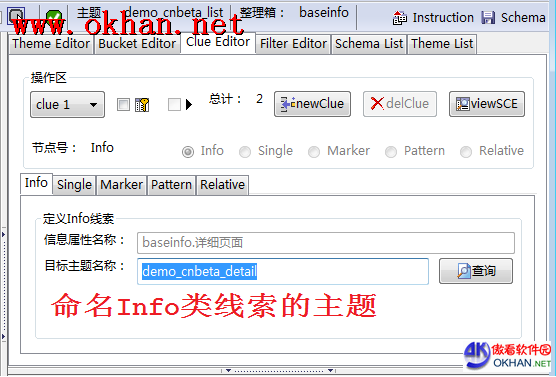

2 获取新闻详情页面

ͼ2

我们已经在《分级抓取》一文中讲过如何抓取二级话题的线索。图2展示了再次抓取下一级线索的方法。信息类线索,在线索编辑器工作台上,将下一级主题命名为demo_cnbeta_detail(如图3)所示)。

ͼ3

定义 Info 类线程的目的有两个:

进行分层爬取,爬取新闻列表再爬取详细的新闻内容为了避免重复爬取,当发现重复率超过设定时终止爬取过程,将在后续章节详细讲解

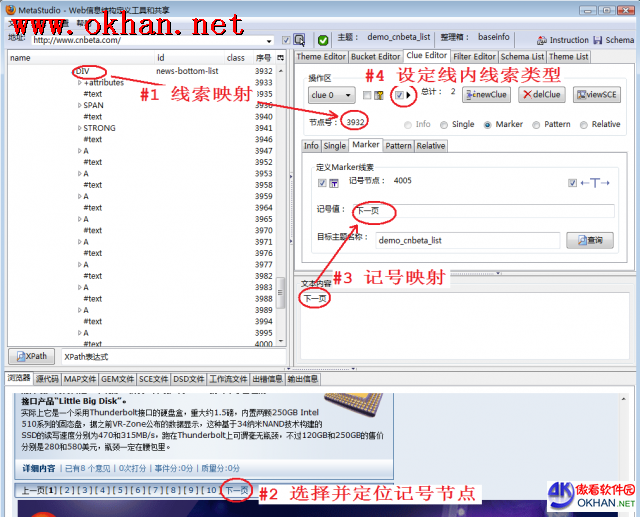

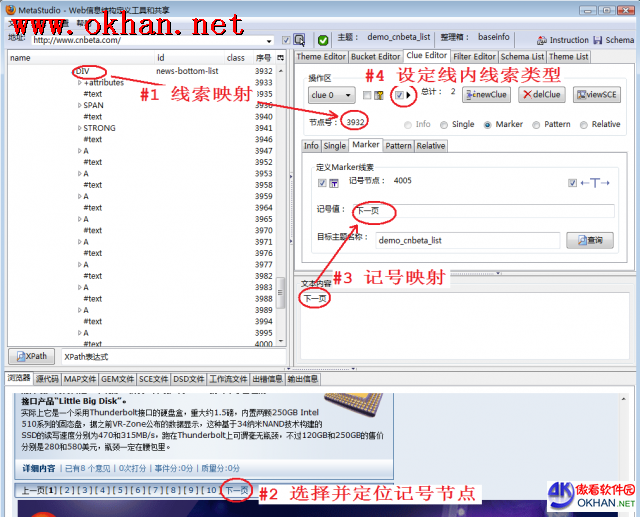

3 翻转和爬取多个页面

ͼ4

为了翻转和抓取所有页面,需要创建一个线索。图 4 显示了主要步骤。详情请参阅《爬当当商品价格》:

将代表整个分页区域的DOM节点映射到这条线索上,相当于指定了一个网页区域,分页超链接可以定位到该区域。我们使用标记线索类型来定位翻页线索,“下一页”是标记值 进行标记映射,标记值和标记节点序号会自动填写到线索编辑器工作台中来设置内联线索类型。该类型主要用于翻页和抓取。选择此类型后,当前主题名称将自动填写到目标主题名称输入框中。

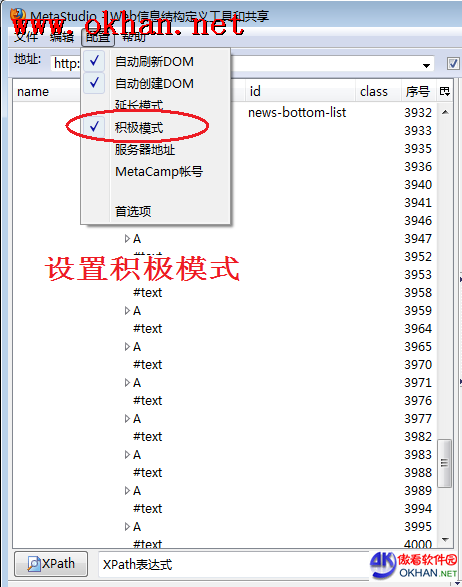

4 设置AJAX获取模式

ͼ5

如图5,选择MetaStudio的菜单“Configuration”->“Aggressive Mode”设置AJAX捕获模式。

在《分页与抓取优秀亚马逊》一文中,我们同时设置了“激进模式”和“扩展模式”,两种模式并没有绑定在一起。这个目标网站不会在每次翻页时加载另一个网页,而是对网页内容进行部分修改,所以设置“扩展模式”是没有意义的。

5只抓取最新消息

通常我们会定期(例如一天)抓取新闻列表,如果发现新新闻,我们会抓取它的 URL 并创建下一级线索以抓取最新的新闻内容。如果发现新闻列表中的所有新闻都是之前爬过的新闻,停止翻页和爬取。这需要一个周期性的自动爬取方法。需要编辑周期性取指调度指令文件。此文件必须命名为 crontab.xml 并存储在 $HOME/.datascraper 目录中。目录结构的详细说明请参考《抓取当当商品价格》。下面是 crontab.xml 文件的内容:

true

5

3600

false

demo_cnbeta_list

demo_cnbeta_list

false

80

-1

-1

false

0

true

23

1800

false

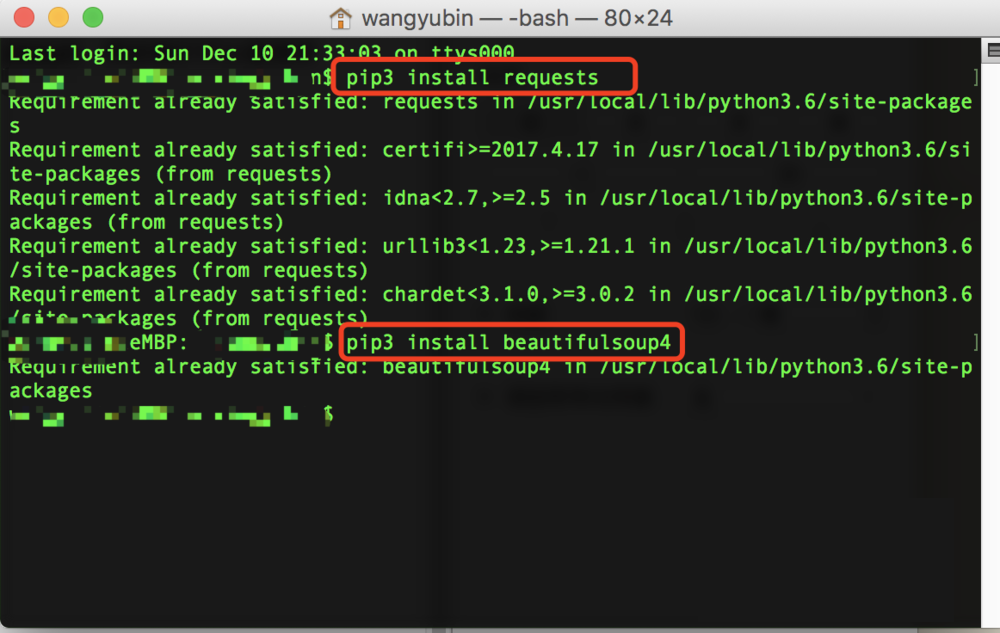

demo_cnbeta_detail

false

80

-1

-1

false

0

所有参数的含义在《周期性爬取调度指令文件》中有说明,而“只抓取最新消息”与抓取主题demo_cnbeta_list的dupRatio参数有关,80表示80%,也就是说如果页面是爬取时发现连续三个页面爬取的URL地址有80%之前已经被爬取过,则终止翻页爬取。

注1:当前版本的MetaSeeker只能判断抓取到的下一级线索的重复率,不能判断抓取数据的重复率。

注意2:请不要直接使用上面的crontab.xml,因为MetaSeeker服务器上还没有定义信息结构demo_cnbeta_detail,会导致周期性爬取失败。 查看全部

网页新闻抓取(采用AJAX技术的网站越来越多,我们有必要通过更多案例讲解)

越来越多的网站在使用AJAX技术,我们有必要通过更多的案例来说明如何准确捕捉Javascript/JS动态生成的内容。这次我们要在cnbeta网站上抓取数字产品新闻。进入这个网站的首页,可以看到一个新闻列表,列表中有多条新闻,每条包括标题、基本信息和摘要。用浏览器访问这个网页,发现新闻列表的第一页和普通网页一样。翻到第二页后,使用浏览器的查看源代码功能,无论现在看到哪个页面,都可以看到HTML源代码没有变化。分页,HTML源代码仍然是第一页。原来 网站 翻页时应使用Javascript动态刷新新闻列表。这种情况会阻碍普通网络爬虫和普通网络爬虫的工作,因为这类网络爬虫一般会向目标服务器发送HTTP GET。消息,获取 HTML 文档,然后使用正则表达式或 DOM 解析方法提取网页上的内容。当需要跳转到其他页面时,由于其他页面没有独立的URL网址,无法发送HTTP GET消息,只能通过人工干预,嗅探Javascript发送给网站的消息是什么,通过获取其他分页内容模拟消息。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。这种情况会阻碍普通网络爬虫和普通网络爬虫的工作,因为这类网络爬虫一般会向目标服务器发送HTTP GET。消息,获取 HTML 文档,然后使用正则表达式或 DOM 解析方法提取网页上的内容。当需要跳转到其他页面时,由于其他页面没有独立的URL网址,无法发送HTTP GET消息,只能通过人工干预,嗅探Javascript发送给网站的消息是什么,通过获取其他分页内容模拟消息。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。这种情况会阻碍普通网络爬虫和普通网络爬虫的工作,因为这类网络爬虫一般会向目标服务器发送HTTP GET。消息,获取 HTML 文档,然后使用正则表达式或 DOM 解析方法提取网页上的内容。当需要跳转到其他页面时,由于其他页面没有独立的URL网址,无法发送HTTP GET消息,只能通过人工干预,嗅探Javascript发送给网站的消息是什么,通过获取其他分页内容模拟消息。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。获取 HTML 文档,然后使用正则表达式或 DOM 解析方法提取网页上的内容。当需要跳转到其他页面时,由于其他页面没有独立的URL网址,无法发送HTTP GET消息,只能通过人工干预,嗅探Javascript发送给网站的消息是什么,通过获取其他分页内容模拟消息。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。获取 HTML 文档,然后使用正则表达式或 DOM 解析方法提取网页上的内容。当需要跳转到其他页面时,由于其他页面没有独立的URL网址,无法发送HTTP GET消息,只能通过人工干预,嗅探Javascript发送给网站的消息是什么,通过获取其他分页内容模拟消息。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。嗅探 Javascript 发送给 网站 的消息,并通过模拟消息获取其他分页内容。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。嗅探 Javascript 发送给 网站 的消息,并通过模拟消息获取其他分页内容。使用 MetaSeeker 网络爬虫,可以完全抛弃嗅探方式,像爬取普通网页一样爬取 AJAX网站 内容。

本文还将讲解另一种爬取技巧:在翻转新闻列表时,假设某个页面中的新闻之前已经被爬取过,停止向下翻页,即只抓取最新的新闻。它是追踪论坛、博客、微博、新闻网站等最常用的技术,也是构建企业竞争情报系统必不可少的功能。

爬取目标分析:

翻转和抓取多个页面。之前爬取二级URL时,停止爬取进程

注1:可以使用MetaStudio加载信息结构demo_cnbeta_list,阅读起来比较容易理解。请注意,着陆页的结构可能会发生变化,这可能会导致信息结构加载不成功。请参考“修改无效信息结构”修改信息结构。

注意 2:本文不是介绍性教程。如果您对 MetaSeeker 不熟悉,建议按照章节顺序阅读《MetaSeeker 崩溃手册》。

1 获取新闻摘要数据

ͼ1

首先,需要定义数据抓取规则。所谓数据抓取规则,就是指定如何从网页中抓取新闻列表数据。图1展示了数据映射和FreeFormat映射的过程,主要包括以下步骤:

以新闻列表中的第一条新闻为例,对其进行数据映射和FreeFormat映射。为了获取新闻数据,需要进行数据映射和FreeFormat映射,其中FreeFormat映射不是必须的,如果网页具有表示DOM节点的语义,可以使用@class或@id属性来精确定位被抓取的内容,然后执行 FreeFormat 映射。详细操作流程请参考《捕捉京东商品价格》。为了捕捉新闻列表中的每一条新闻,都要进行FreeFormat映射,也就是所谓的多实例捕捉。FreeFormat映射不是唯一的方法,这个页面的每条新闻都有@class="newslist",非常适合爬取多个实例。如果没有合适的 FreeFormat,您可以使用示例复制方法。请参考“捕获当当商品价格”设置至少一个信息属性的关键属性。关键属性的描述请参考《MetaStudio 用户手册》。设置关键特性后,DataScraper 可以运行在加速模式,提高爬取速度。如果DataScraper菜单项“Configuration”->“Normal Mode”没有勾选,DataScraper进入加速模式。

2 获取新闻详情页面

ͼ2

我们已经在《分级抓取》一文中讲过如何抓取二级话题的线索。图2展示了再次抓取下一级线索的方法。信息类线索,在线索编辑器工作台上,将下一级主题命名为demo_cnbeta_detail(如图3)所示)。

ͼ3

定义 Info 类线程的目的有两个:

进行分层爬取,爬取新闻列表再爬取详细的新闻内容为了避免重复爬取,当发现重复率超过设定时终止爬取过程,将在后续章节详细讲解

3 翻转和爬取多个页面

ͼ4

为了翻转和抓取所有页面,需要创建一个线索。图 4 显示了主要步骤。详情请参阅《爬当当商品价格》:

将代表整个分页区域的DOM节点映射到这条线索上,相当于指定了一个网页区域,分页超链接可以定位到该区域。我们使用标记线索类型来定位翻页线索,“下一页”是标记值 进行标记映射,标记值和标记节点序号会自动填写到线索编辑器工作台中来设置内联线索类型。该类型主要用于翻页和抓取。选择此类型后,当前主题名称将自动填写到目标主题名称输入框中。

4 设置AJAX获取模式

ͼ5

如图5,选择MetaStudio的菜单“Configuration”->“Aggressive Mode”设置AJAX捕获模式。

在《分页与抓取优秀亚马逊》一文中,我们同时设置了“激进模式”和“扩展模式”,两种模式并没有绑定在一起。这个目标网站不会在每次翻页时加载另一个网页,而是对网页内容进行部分修改,所以设置“扩展模式”是没有意义的。

5只抓取最新消息

通常我们会定期(例如一天)抓取新闻列表,如果发现新新闻,我们会抓取它的 URL 并创建下一级线索以抓取最新的新闻内容。如果发现新闻列表中的所有新闻都是之前爬过的新闻,停止翻页和爬取。这需要一个周期性的自动爬取方法。需要编辑周期性取指调度指令文件。此文件必须命名为 crontab.xml 并存储在 $HOME/.datascraper 目录中。目录结构的详细说明请参考《抓取当当商品价格》。下面是 crontab.xml 文件的内容:

true

5

3600

false

demo_cnbeta_list

demo_cnbeta_list

false

80

-1

-1

false

0

true

23

1800

false

demo_cnbeta_detail

false

80

-1

-1

false

0

所有参数的含义在《周期性爬取调度指令文件》中有说明,而“只抓取最新消息”与抓取主题demo_cnbeta_list的dupRatio参数有关,80表示80%,也就是说如果页面是爬取时发现连续三个页面爬取的URL地址有80%之前已经被爬取过,则终止翻页爬取。

注1:当前版本的MetaSeeker只能判断抓取到的下一级线索的重复率,不能判断抓取数据的重复率。

注意2:请不要直接使用上面的crontab.xml,因为MetaSeeker服务器上还没有定义信息结构demo_cnbeta_detail,会导致周期性爬取失败。

网页新闻抓取(自动化抽取新闻类网站正文的算法论文——《基于文本及符号密度的网页正文提取方法》)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-03-18 01:22

项目起源

这个项目的开发源于我在CNKI上找到了一篇关于自动提取新闻网站文本的算法论文——《基于文本和符号密度的网页文本提取方法》

本文描述的算法看起来简洁、清晰、合乎逻辑。但是由于论文只讲了算法的原理,并没有具体的语言实现,所以我按照论文用Python实现了这个提取器。并使用今日头条、网易新闻、流浪星、观察者网、凤凰网、腾讯新闻、ReadHub、新浪新闻进行测试,发现提取效果非常好,准确率几乎100%。

项目状态

在论文中描述的文本提取的基础上,我增加了标题、发表时间和文章作者的自动检测和提取。

最终输出如下图所示:

目前,这个项目是一个非常非常早期的Demo。发布是希望能尽快得到大家的反馈,以便更有针对性的开发。

本项目命名为提取器,而不是爬虫,以避免不必要的风险。因此,本项目的输入是HTML,输出是字典。请使用适当的方法获取目标网站的HTML。

这个项目没有也不会提供主动请求 网站 HTML 的能力。

如何使用

项目代码中的GeneralNewsCrawler.py 提供了本项目的基本使用示例。

from GeneralNewsCrawler import GeneralNewsExtractor

extractor = GeneralNewsExtractor()

html = '你的目标网页正文'

result = extractor.extract(html)

print(result)

对于大多数新闻页面,以上内容就可以了。

但是,某些新闻页面下会有评论。评论中可能会有冗长的评论。它们看起来更像文本而不是真正的新闻文本。因此extractor.extract()方法还有一个默认参数noise_mode_list,用于网页预处理。提前删除整个评论区。

noise_mode_list 的值是一个列表,列表中的每个元素都是一个 XPath,对应的是你需要提前移除的目标标签,可能会产生噪音。

例如,观察者网络下方评论区对应的Xpath为//div[@class="comment-list"]。所以在提取观察者网络的时候,为了防止评论干扰,可以加上这个参数:

result = extractor.extract(html, noise_node_list=['//div[@class="comment-list"]'])

test文件夹中网页的提取结果请查看result.txt。

已知问题 目前该项目仅适用于新闻页面的信息提取。如果目标网站不是新闻页面,也不是今日头条的专辑类型文章,提取结果可能不符合预期。可能有一些新闻页面,提取结果中的作者为空字符串。这可能是因为 文章 本身没有作者,或者没有覆盖现有的正则表达式。托多论文修改

在使用Python实现这个提取器的过程中,发现论文中的公式和方法存在一些缺陷,会导致部分节点报错。我将写几篇单独的 文章 帖子来介绍这里的变化。

项目地址: 查看全部

网页新闻抓取(自动化抽取新闻类网站正文的算法论文——《基于文本及符号密度的网页正文提取方法》)

项目起源

这个项目的开发源于我在CNKI上找到了一篇关于自动提取新闻网站文本的算法论文——《基于文本和符号密度的网页文本提取方法》

本文描述的算法看起来简洁、清晰、合乎逻辑。但是由于论文只讲了算法的原理,并没有具体的语言实现,所以我按照论文用Python实现了这个提取器。并使用今日头条、网易新闻、流浪星、观察者网、凤凰网、腾讯新闻、ReadHub、新浪新闻进行测试,发现提取效果非常好,准确率几乎100%。

项目状态

在论文中描述的文本提取的基础上,我增加了标题、发表时间和文章作者的自动检测和提取。

最终输出如下图所示:

目前,这个项目是一个非常非常早期的Demo。发布是希望能尽快得到大家的反馈,以便更有针对性的开发。

本项目命名为提取器,而不是爬虫,以避免不必要的风险。因此,本项目的输入是HTML,输出是字典。请使用适当的方法获取目标网站的HTML。

这个项目没有也不会提供主动请求 网站 HTML 的能力。

如何使用

项目代码中的GeneralNewsCrawler.py 提供了本项目的基本使用示例。

from GeneralNewsCrawler import GeneralNewsExtractor

extractor = GeneralNewsExtractor()

html = '你的目标网页正文'

result = extractor.extract(html)

print(result)

对于大多数新闻页面,以上内容就可以了。

但是,某些新闻页面下会有评论。评论中可能会有冗长的评论。它们看起来更像文本而不是真正的新闻文本。因此extractor.extract()方法还有一个默认参数noise_mode_list,用于网页预处理。提前删除整个评论区。

noise_mode_list 的值是一个列表,列表中的每个元素都是一个 XPath,对应的是你需要提前移除的目标标签,可能会产生噪音。

例如,观察者网络下方评论区对应的Xpath为//div[@class="comment-list"]。所以在提取观察者网络的时候,为了防止评论干扰,可以加上这个参数:

result = extractor.extract(html, noise_node_list=['//div[@class="comment-list"]'])

test文件夹中网页的提取结果请查看result.txt。

已知问题 目前该项目仅适用于新闻页面的信息提取。如果目标网站不是新闻页面,也不是今日头条的专辑类型文章,提取结果可能不符合预期。可能有一些新闻页面,提取结果中的作者为空字符串。这可能是因为 文章 本身没有作者,或者没有覆盖现有的正则表达式。托多论文修改

在使用Python实现这个提取器的过程中,发现论文中的公式和方法存在一些缺陷,会导致部分节点报错。我将写几篇单独的 文章 帖子来介绍这里的变化。

项目地址:

网页新闻抓取(实验内容这里不用管拓展视频是什么,视频涉及的内容很重要 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2022-03-16 15:18

)

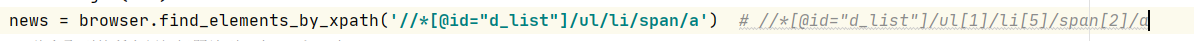

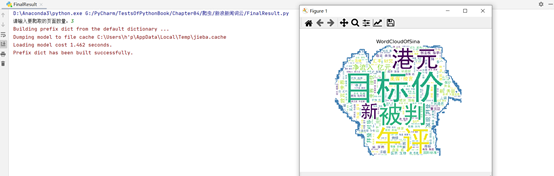

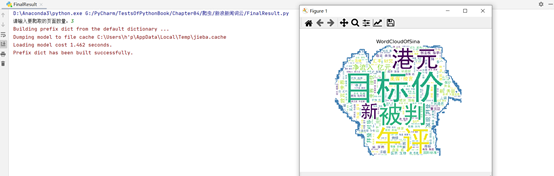

新浪新闻动态网页爬取+热词云分析实验内容

扩展视频在这里无所谓,视频中涉及的内容很简单。

日常生活中,我们经常看到“年度热词”,你会好奇这是怎么获得的?

我们最常见的想法是计算机通过分析大数据来获得它。

下面我用这个例子来展示详细的过程

上面的代码

代码有注释,大家都懂!

from selenium import webdriver

from selenium.common.exceptions import NoSuchElementException

import jieba

from wordcloud import WordCloud

from imageio import imread

import matplotlib.pyplot as plt

def getSinaNews(pages):

# 要爬取的网页

url = 'https://news.sina.com.cn/roll/'

# 获取无界面浏览器

# chrome_options = webdriver.ChromeOptions()

# chrome_options.add_argument('--headless')

# browser = webdriver.Chrome(options=chrome_options)

# 有界面模式

browser = webdriver.Chrome()

# 爬

news_list = ''

while pages > 0:

try:

browser.get(url)

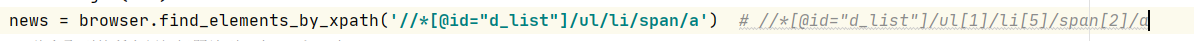

news = browser.find_elements_by_xpath('//*[@id="d_list"]/ul/li/span/a')

# 将爬取到的所有新闻标题放到一个String中

for i in news:

news_list = news_list + str(i.text)

except NoSuchElementException:

print('NoSuchElementException')

browser.close()

continue

# 找到下一页按钮,并点击

'''//*[@id="d_list"]/div/span[15]/a'''

browser.find_element_by_xpath('//*[@id="d_list"]/div/span/a').click()

pages = pages - 1

browser.quit()

return news_list

def createWordCloud(news_list):

bg_image = imread("bg.jpg")

stopwords = [line.strip() for line in open('StopWords.txt', encoding='utf-8').readlines()]

mytext = jieba.cut(news_list, cut_all=False)

wt = " /".join(mytext)

# 设置词云相关参数

word_cloud = WordCloud(

# 设置背景颜色

background_color="white",

# 设置最大显示的字数

max_words=200,

# 设置背景图片

mask=bg_image,

# 此处添加停用词库

stopwords=stopwords,

# 设置中文字体,词云默认字体是“DroidSansMono.ttf字体库”,不支持中文

font_path="SimHei.ttf",

# 设置字体最大值

max_font_size=500,

# 设置有多少种随机生成状态,即有多少种配色方案

random_state=30,

# 轮廓线宽度

contour_width=3,

# 轮廓线颜色

contour_color='steelblue',

)

mycloud = word_cloud.generate(wt) # 生成词云

# 设置生成图片的标题

plt.title('WordCloudOfSina') # 必须得用英文,否则报错且不显示

plt.imshow(mycloud)

# 设置是否显示 X、Y 轴的下标

plt.axis("off")

plt.show()

if __name__ == '__main__':

page = eval(input('请输入要爬取的页面数量:'))

news_list = getSinaNews(page)

createWordCloud(news_list)

代码中涉及的图片,这个图片是在网上找的,主要是作为词云的背景。

涉及的文件也有好几个,都是我放到百度网盘上的,需要自己捡

关联:

提取码:v3ad

复制完这个内容后,打开百度网盘手机应用,操作起来更方便。

步骤分析首先你要明白,并不是所有的网站都能被你爬上去。网站 的部分源代码只有在您访问时才会为您呈现和生成。因此,万无一失的方法是让计算机模拟人类进行自动访问。这里使用的来自 selenium 库。可以实现自动页面跳转。在查找要抓取的内容时,您可以使用浏览器的检查功能。先用F12打开检查,然后按图中的顺序操作。点击第一步,点击第二步,完成1、2步后,会定位到位置3,在3的基础上点击右键。

这得到下面的评论部分!,通过观察去掉里面的数字部分,就是他的“通项公式”:

实验结果

查看全部

网页新闻抓取(实验内容这里不用管拓展视频是什么,视频涉及的内容很重要

)

新浪新闻动态网页爬取+热词云分析实验内容

扩展视频在这里无所谓,视频中涉及的内容很简单。

日常生活中,我们经常看到“年度热词”,你会好奇这是怎么获得的?

我们最常见的想法是计算机通过分析大数据来获得它。

下面我用这个例子来展示详细的过程

上面的代码

代码有注释,大家都懂!

from selenium import webdriver

from selenium.common.exceptions import NoSuchElementException

import jieba

from wordcloud import WordCloud

from imageio import imread

import matplotlib.pyplot as plt

def getSinaNews(pages):

# 要爬取的网页

url = 'https://news.sina.com.cn/roll/'

# 获取无界面浏览器

# chrome_options = webdriver.ChromeOptions()

# chrome_options.add_argument('--headless')

# browser = webdriver.Chrome(options=chrome_options)

# 有界面模式

browser = webdriver.Chrome()

# 爬

news_list = ''

while pages > 0:

try:

browser.get(url)

news = browser.find_elements_by_xpath('//*[@id="d_list"]/ul/li/span/a')

# 将爬取到的所有新闻标题放到一个String中

for i in news:

news_list = news_list + str(i.text)

except NoSuchElementException:

print('NoSuchElementException')

browser.close()

continue

# 找到下一页按钮,并点击

'''//*[@id="d_list"]/div/span[15]/a'''

browser.find_element_by_xpath('//*[@id="d_list"]/div/span/a').click()

pages = pages - 1

browser.quit()

return news_list

def createWordCloud(news_list):

bg_image = imread("bg.jpg")

stopwords = [line.strip() for line in open('StopWords.txt', encoding='utf-8').readlines()]

mytext = jieba.cut(news_list, cut_all=False)

wt = " /".join(mytext)

# 设置词云相关参数

word_cloud = WordCloud(

# 设置背景颜色

background_color="white",

# 设置最大显示的字数

max_words=200,

# 设置背景图片

mask=bg_image,

# 此处添加停用词库

stopwords=stopwords,

# 设置中文字体,词云默认字体是“DroidSansMono.ttf字体库”,不支持中文

font_path="SimHei.ttf",

# 设置字体最大值

max_font_size=500,

# 设置有多少种随机生成状态,即有多少种配色方案

random_state=30,

# 轮廓线宽度

contour_width=3,

# 轮廓线颜色

contour_color='steelblue',

)

mycloud = word_cloud.generate(wt) # 生成词云

# 设置生成图片的标题

plt.title('WordCloudOfSina') # 必须得用英文,否则报错且不显示

plt.imshow(mycloud)

# 设置是否显示 X、Y 轴的下标

plt.axis("off")

plt.show()

if __name__ == '__main__':

page = eval(input('请输入要爬取的页面数量:'))

news_list = getSinaNews(page)

createWordCloud(news_list)

代码中涉及的图片,这个图片是在网上找的,主要是作为词云的背景。

涉及的文件也有好几个,都是我放到百度网盘上的,需要自己捡

关联:

提取码:v3ad

复制完这个内容后,打开百度网盘手机应用,操作起来更方便。

步骤分析首先你要明白,并不是所有的网站都能被你爬上去。网站 的部分源代码只有在您访问时才会为您呈现和生成。因此,万无一失的方法是让计算机模拟人类进行自动访问。这里使用的来自 selenium 库。可以实现自动页面跳转。在查找要抓取的内容时,您可以使用浏览器的检查功能。先用F12打开检查,然后按图中的顺序操作。点击第一步,点击第二步,完成1、2步后,会定位到位置3,在3的基础上点击右键。

这得到下面的评论部分!,通过观察去掉里面的数字部分,就是他的“通项公式”:

实验结果

网页新闻抓取( 网易新闻网为例的主要流程和代码实现(爬虫为例) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 368 次浏览 • 2022-03-14 00:01

网易新闻网为例的主要流程和代码实现(爬虫为例)

)

新闻爬虫和爬取结果查询网站 build(二)

概括

本章将介绍爬虫的主要流程和代码实现。

爬虫流程如下:

在爬虫中,首先构造一个模仿浏览器的请求,并使用header来防止网站屏蔽爬虫代码。请求函数可以访问指定的url,并设置回调函数来处理生成的html页面。

var headers = {

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_10_1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.65 Safari/537.36'

}

function request(url, callback) {

var options = {

url: url,

encoding: null,

headers: headers,

timeout: 10000

}

myRequest(options, callback)

}

数据库建表和连接的准备工作

创建表语句(新闻、关键字两个表):

CREATE TABLE news (

id_news serial UNIQUE,

url text DEFAULT NULL UNIQUE,

source_name varchar(50) DEFAULT NULL,

source_encoding varchar(45) DEFAULT NULL,

title varchar(100) DEFAULT NULL,

publish_date date DEFAULT CURRENT_TIMESTAMP,

content text,

PRIMARY KEY (id_news)

);

CREATE TABLE keywords (

id_word serial UNIQUE,

id_news int,

word varchar(50) DEFAULT NULL

);

连接并配置数据库

本项目使用连接池方式连接数据库。

建立数据库连接池的好处:

节省资源和高效的用户访问

npm install pg

var pg = require('pg');

var config = {

host:"127.0.0.1",

user:"root",

database:"spider",

password:"syz",

port:5432,

max:20, // 连接池最大连接数

idleTimeoutMillis:3000, // 连接最大空闲时间 3s

}

var pool = new pg.Pool(config);

爬取网页(网易新闻、中新网财经频道、雪球网)

以网易新闻为例详细讲解:网易新闻

分析种子页面

从上图可以看出,中间新闻的url都在“div”下。在这个种子页中,需要爬取每条新闻的url,具体代码如下:

var source_name = "网易新闻";

var myEncoding = "utf-8";

var seedURL = 'https://news.163.com/';

var seedURL_format = "$('a')";

var title_format = "$('title').text()";

var date_format = "$('html#ne_wrap').attr(\"data\-publishtime\")";//

var pgsql = require('../pg.js');

var Iconv = require('iconv-lite');

var myRequest = require('request');

var myCheerio = require('cheerio');

var url_reg = /\/(\d{2})\/(\d{4})\/(\d{2})\/([A-Z0-9]{16}).html/;

var regExp = /((\d{4}|\d{2})(\-|\/|\.)\d{1,2}\3\d{1,2})|(\d{4}年\d{1,2}月\d{1,2}日)/

var headers = {

'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_10_1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.65 Safari/537.36'

}

function request(url, callback) {//request module fetching url

var options = {

url: url,

encoding: null,

headers: headers,

timeout: 10000

}

myRequest(options, callback)

}

request(seedURL, function (err, res, data) {

var buf = Iconv.encode(data, 'utf-8');

var html = Iconv.decode(buf, myEncoding);

var $ = myCheerio.load(html, { decodeEntities: true });

try {

seedurl_news = eval(seedURL_format);

} catch (e) { };

seedurl_news.each(function(){

var myURL = "";

try {

var href = "";

href = $(this).attr("href");

if (href == undefined) return;

if (href.toLowerCase().indexOf('https://') >= 0 || href.toLowerCase().indexOf('http://') >= 0) myURL = href;

else if (href.startsWith('//')) myURL = 'http:' + href;

else myURL = seedURL.substr(0, seedURL.lastIndexOf('/') + 1) + href;

}catch (e) {

}

if (!url_reg.test(myURL)) return;

var news = {};

news.url = myURL;

news.source_name = source_name;

news.source_encoding = myEncoding;

var news_url_Sql = 'select url from news where url= $1';

var news_url_Sql_Params = [myURL];

pgsql.query(news_url_Sql, news_url_Sql_Params, function(err, result) {

if (err) {

console.log(err)