网络爬虫

网络爬虫是哪些

采集交流 • 优采云 发表了文章 • 0 个评论 • 225 次浏览 • 2020-06-15 08:01

网络爬虫介绍:

网络爬虫也可以称作网路蜘蛛,它是一种手动获取网页内容的程序,爬虫抓取的网页将会被搜索引擎系统存储,进行一定的剖析、过滤爬虫软件是什么,并且构建索引,以便以后的用户才能查询到这个页面。这个获取信息的程序就是网路爬虫程序,也可以说是网路蜘蛛程序。

网络爬虫跟搜索引擎的关系,网络爬虫是为搜索引擎搜集内容的爬虫软件是什么,搜索引擎所展示的内容大部分都是爬虫搜集的内容。而搜索引擎所展示的内容都各大网站的内容,那么搜集这种各大网站内容的程序就叫做网路爬虫程序。各大网而它们的关系,我们可以例如搜索引擎是老总,网络爬虫就是工作人员,他们的关系如同是上下级关系的。所以说网路爬虫跟搜索引擎的关系就是上下级关系。

网络爬虫是能守漫游的开式进行抓取的,网络爬虫它爬到一个页面后,看到一个链接,然后沿着那种链接又爬到另外一个页面,爬虫是不停的从一个页面跳转到另外一个页面的,它是一边下载这个网页的内容,一边在提取这个网页中的链接,那个页面上所有的链接都统一放置在一个公用的“待抓取列表”里面的。在这里说一下,网络爬虫它有一个特性,什么特征呢?

网络爬虫它在访问你网站之前,它是不会去做判定这个网页本身怎么样的,也不对网页内容判定就进行抓取的。但是有一点就是会有优先级的界定,怎么来界定的呢?就是尽可能不抓取重复的内容,尽量抓取重要的内容,对用户有用的内容,比如网站的公共部份网路蜘蛛都会尽量的不去抓取了。搜索引擎它会同时派出多个爬虫进行多线程的抓取,所有被爬虫抓取的网页都将会被系统存储,进行一定的剖析、过滤、去重。并构建索引,以便以后的查询和检索。

网络爬虫的分类:

网络爬虫他有好几种,我们可以按照搜索引擎来进行分类,可以分以下几种,比如:

1、百度的爬虫我们叫Baiduspider也称作百度蜘蛛

2、谷歌的爬虫我们叫Googlebot也称作微软机器人

3、SOSO爬虫我们叫sosospider

总结:了解了网路爬虫的介绍,它的工作流程,还有网路爬虫的分类,对我们在做SEO优化的时侯是有一定的帮助的,因为在我们学习,SEO基础的时侯,都是要学关于网路蜘蛛一些相关知识的。建网站,用.top域名。 查看全部

在生活中,大家都见过蚊子吧,而在这篇文章中,就是讲有关蟑螂,这个蟑螂不是普通的蟑螂,他一种网路程序,只是我们把它称作网路爬虫也可以称作网路蜘蛛。那么,在这里,我就给大空谈谈菜鸟必知的SEO基础二 关于网路爬虫的想关知识。首先,来对这个网路爬虫做个简单的介绍。

网络爬虫介绍:

网络爬虫也可以称作网路蜘蛛,它是一种手动获取网页内容的程序,爬虫抓取的网页将会被搜索引擎系统存储,进行一定的剖析、过滤爬虫软件是什么,并且构建索引,以便以后的用户才能查询到这个页面。这个获取信息的程序就是网路爬虫程序,也可以说是网路蜘蛛程序。

网络爬虫跟搜索引擎的关系,网络爬虫是为搜索引擎搜集内容的爬虫软件是什么,搜索引擎所展示的内容大部分都是爬虫搜集的内容。而搜索引擎所展示的内容都各大网站的内容,那么搜集这种各大网站内容的程序就叫做网路爬虫程序。各大网而它们的关系,我们可以例如搜索引擎是老总,网络爬虫就是工作人员,他们的关系如同是上下级关系的。所以说网路爬虫跟搜索引擎的关系就是上下级关系。

网络爬虫是能守漫游的开式进行抓取的,网络爬虫它爬到一个页面后,看到一个链接,然后沿着那种链接又爬到另外一个页面,爬虫是不停的从一个页面跳转到另外一个页面的,它是一边下载这个网页的内容,一边在提取这个网页中的链接,那个页面上所有的链接都统一放置在一个公用的“待抓取列表”里面的。在这里说一下,网络爬虫它有一个特性,什么特征呢?

网络爬虫它在访问你网站之前,它是不会去做判定这个网页本身怎么样的,也不对网页内容判定就进行抓取的。但是有一点就是会有优先级的界定,怎么来界定的呢?就是尽可能不抓取重复的内容,尽量抓取重要的内容,对用户有用的内容,比如网站的公共部份网路蜘蛛都会尽量的不去抓取了。搜索引擎它会同时派出多个爬虫进行多线程的抓取,所有被爬虫抓取的网页都将会被系统存储,进行一定的剖析、过滤、去重。并构建索引,以便以后的查询和检索。

网络爬虫的分类:

网络爬虫他有好几种,我们可以按照搜索引擎来进行分类,可以分以下几种,比如:

1、百度的爬虫我们叫Baiduspider也称作百度蜘蛛

2、谷歌的爬虫我们叫Googlebot也称作微软机器人

3、SOSO爬虫我们叫sosospider

总结:了解了网路爬虫的介绍,它的工作流程,还有网路爬虫的分类,对我们在做SEO优化的时侯是有一定的帮助的,因为在我们学习,SEO基础的时侯,都是要学关于网路蜘蛛一些相关知识的。建网站,用.top域名。

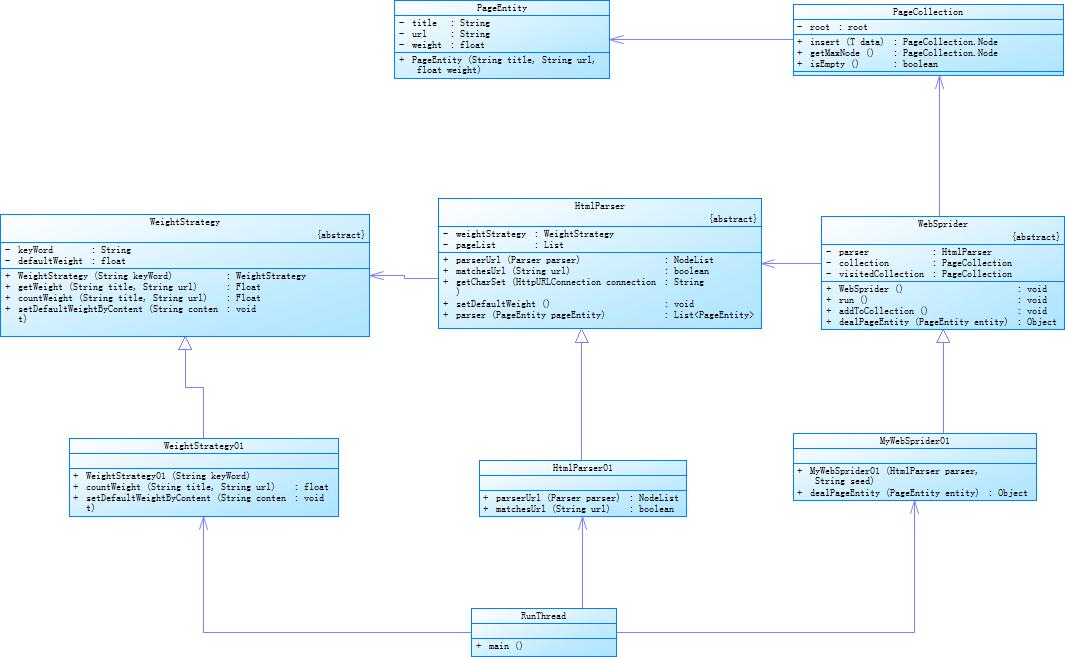

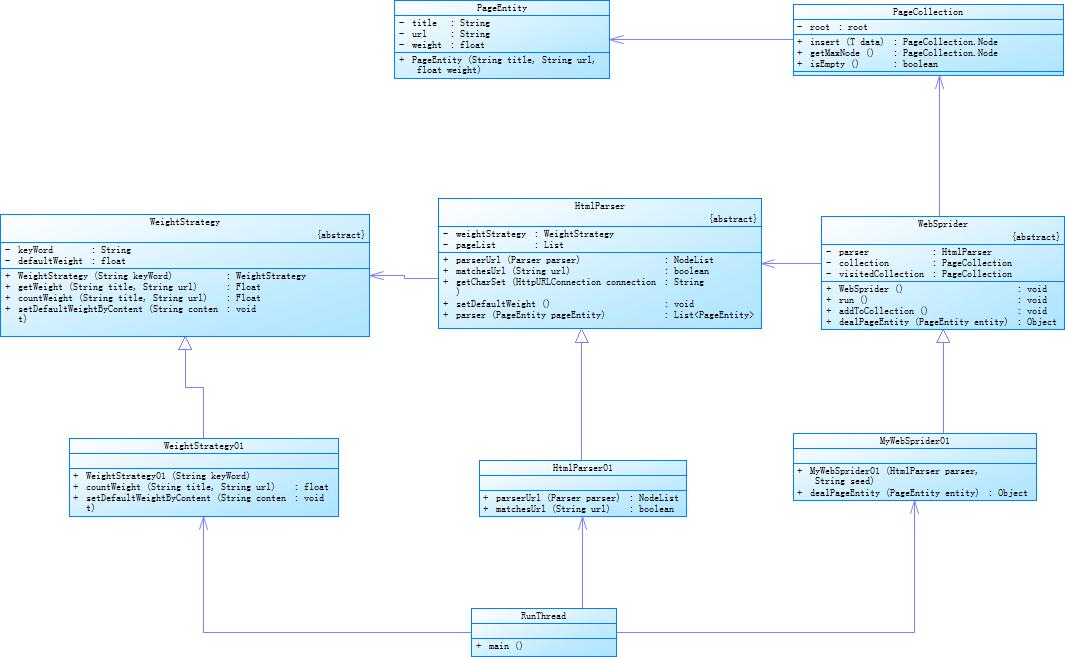

java爬虫框架有什么,各有哪些特征

采集交流 • 优采云 发表了文章 • 0 个评论 • 394 次浏览 • 2020-06-15 08:00

优采云·云采集网络爬虫软件 java 爬虫框架有什么,各有哪些特征目前主流的 Java 爬虫框架主要有 Nutch、Crawler4j、WebMagic、 scrapy、WebCollector 等,各有各的特性,大家可以依照自己的需求 选择使用, 下面为你们详尽介绍常见的 java 爬虫框架有什么?各有什 么特征? 常见的 java 爬虫框架有什么 1、Nutch Nutch 是一个基于 Lucene,类似 Google 的完整网路搜索引擎解决方 案,基于 Hadoop 的分布式处理模型保证了系统的性能,类似 Eclipse 的插件机制保证了系统的可客户化, 而且很容易集成到自己的应用之 中。 总体上 Nutch 可以分为 2 个部份:抓取部份和搜索部份。抓取程序 抓取页面并把抓取回去的数据弄成反向索引, 搜索程序则对反向索引 搜索回答用户的恳求。抓取程序和搜索程序的插口是索引,两者都让优采云·云采集网络爬虫软件 用索引中的主键。抓取程序和搜索程序可以分别坐落不同的机器上。 下面详尽介绍一下抓取部份。 Nutch 抓取部份:抓取程序是被 Nutch 的抓取工具驱动的。这是一组工具,用来构建和 维护几个不同的数据结构: web databasejava爬虫框架使用排行, a set of segments, and the index。

下面挨个解释这三个不同的数据结构: 1、The web database, 或者 WebDB。这是一个特殊储存数据结构, 用来映像被抓取网站数据的结构和属性的集合。WebDB 用来储存从 抓取开始(包括重新抓取)的所有网站结构数据和属性。WebDB 只 是被 抓取程序使用,搜索程序并不使用它。WebDB 存储 2 种实体: 页面 和 链接。页面 表示 网络上的一个网页,这个网页的 Url 作为 标示被索引,同时完善一个对网页内容的 MD5 哈希签名。跟网页相 关的其它内容也被储存,包括:页面中的链接数目(外链接),页面 抓取信息(在页面被重复抓取的情况下),还有表示页面级别的分数 score 。链接 表示从一个网页的链接到其它网页的链接。因此 WebDB 可以说是一个网路图,节点是页面,链接是边。优采云·云采集网络爬虫软件 2、Segment 。这是网页的集合,并且它被索引。Segment 的 Fetchlist 是抓取程序使用的 url 列表,它是从 WebDB 中生成的。Fetcher 的输 出数据是从 fetchlist 中抓取的网页。Fetcher 的输出数据先被反向索 引,然后索引后的结果被储存在 segment 中。

Segment 的生命周期 是有限制的,当下一轮抓取开始后它就没有用了。默认的 重新抓取 间隔是 30 天。因此删掉超过这个时间时限的 segment 是可以的。而 且也可以节约不少c盘空间。 Segment 的命名是日期加时间, 因此太 直观的可以看出她们的存活周期。 3、The index。索引库是反向索引所有系统中被抓取的页面,它并不 直接从页面反向索引形成,而是合并好多小的 segment 的索引形成 的。Nutch 使用 Lucene 来构建索引,因此所有 Lucene 相关的工具 API 都拿来构建索引库。需要说明的是 Lucene 的 segment 的概念和 Nutch 的 segment 概念是完全不同的, 不要混淆。 简单来说 Lucene 的 segment 是 Lucene 索引库的一部分, 而 Nutch 的 Segment 是 WebDB 中被抓取和索引的一部分。优采云·云采集网络爬虫软件 2、crawler4jcrawler4j 是 Java 实现的开源网路爬虫。提供了简单易用的插口,可 以在几分钟内创建一个多线程网络爬虫。crawler4j 的使用主要分为两个步骤:实现一个承继自 WebCrawler 的爬虫类; 通过 CrawlController 调用实现的爬虫类。

WebCrawler 是一个抽象类,继承它必须实现两个方式: shouldVisit 和 visit。其中: shouldVisit 是判定当前的 URL 是否早已应当被爬取(访问);visit 则是爬取该 URL 所指向的页面的数据,其传入的参数即是对该 web 页面全部数据的封装对象 Page。另外,WebCrawler 还有其它一些方式可供覆盖,其方式的命名规则 类 似 于 Android 的 命 名 规 则 。 如 getMyLocalData 方法 可 以 返 回优采云·云采集网络爬虫软件 WebCrawler 中的数据;onBeforeExit 方法会在该 WebCrawler 运行结 束前被调用,可以执行一些资源释放之类的工作。开源地址: 3、WebMagic WebMagic 是一个简单灵活的 Java 爬虫框架。基于 WebMagic,你可 以快速开发出一个高效、易维护的爬虫。 WebMagic 的特征:? ? ?简单的 API,可快速上手 模块化的结构,可轻松扩充 提供多线程和分布式支持源码地址:4、WebCollector优采云·云采集网络爬虫软件 是一个无须配置、便于二次开发的 JAVA 爬虫框架(内核),它提供 精 简 的 的 API , 只 需 少 量 代 码 即 可 实 现 一 个 功 能 强 大 的 爬 虫 。

WebCollector-Hadoop 是 WebCollector 的 Hadoop 版本, 支持分布式爬 取。WebCollector在Github上护: 传统的网路爬虫倾向于整站下载,目的是将网站内容原貌下载到本 地,数据的最小单元是单个网页或文件。而 WebCollector 可以通过设 置爬取策略进行定向采集,并可以抽取网页中的结构化信息。5、HeritrixHeritrix 是一个由 java 开发的、开源的网路爬虫,用户可以使用它来 从网上抓取想要的资源。其最出色之处在于它良好的可扩展性,方便 用户实现自己的抓取逻辑。 Heritrix 是个“ArchivalCrawler”——来获取完整的、精确的、站点内 容的深度复制。包括获取图象以及其他非文本内容。抓取并储存相关 的内容。对内容来者不拒,不对页面进行内容上的更改。重新爬行对优采云·云采集网络爬虫软件 相同的 URL 不针对原先的进行替换。爬虫主要通过 Web 用户界面启 动、监控和调整,允许弹性的定义要获取的 url。 Heritrix 是按多线程形式抓取的爬虫,主线程把任务分配给 Teo 线程 (处理线程),每个 Teo 线程每次处理一个 URL。

Teo 线程对每位 URL 执行一遍 URL 处理器链。URL 处理器链包括如下 5 个处理步骤。 (1)预取链:主要是做一些打算工作,例如,对处理进行延后和重新处 理,否决随即的操作。 (2)提取链:主要是下载网页,进行 DNS 转换,填写恳求和响应表单。 (3)抽取链:当提取完成时,抽取感兴趣的 HTML 和 JavaScript,通常 那里有新的要抓取的 URL。 (4)写链:存储抓取结果,可以在这一步直接做全文索引。Heritrix 提 供了用 ARC 格式保存下载结果的 ARCWriterProcessor 实现。 (5)提交链:做和此 URL 相关操作的最后处理。检查什么新提取出的 URL 在抓取范围内,然后把这种 URL 提交给 Frontier。另外都会更新 DNS 缓存信息。6、WebSPHINXWebSPHINX 是一个 Java 类包和 Web 爬虫的交互式开发环境。 Web 爬优采云·云采集网络爬虫软件 虫(也叫作机器人或蜘蛛)是可以手动浏览与处理 Web 页面的程序。 WebSPHINX 由两部份组成:爬虫工作平台和 WebSPHINX 类包。WebSPHINX 是一个 Java 类包和 Web 爬虫的交互式开发环境。

Web 爬 虫(也叫作机器人或蜘蛛)是可以手动浏览与处理 Web 页面的程序。 WebSPHINX 由两部份组成:爬虫工作平台和 WebSPHINX 类包。WebSPHINX 主要用途1)可视化显示页面的集合 2)下载页面到本地c盘用于离线浏览 3)将所有页面拼接成单个页面用于浏览或则复印 4)按照特定的规则从页面中抽取文本字符串 5)用 Java 或 Javascript 开发自定义的爬虫常见的 java 爬虫框架对比优采云·云采集网络爬虫软件 相关阅读:采集搜狗陌陌文章(搜索关键词): 亚马逊商品信息采集: 易迅商品信息采集: 知乎回答内容采集方法: 58 同城电话号码采集: 搜狗陌陌热门文章采集: 优采云·云采集网络爬虫软件 优采云——90 万用户选择的网页数据采集器。 1、操作简单,任何人都可以用:无需技术背景,会上网才能采集。完全可视化 流程,点击滑鼠完成操作,2 分钟即可快速入门。 2、功能强悍,任何网站都可以采:对于点击、登陆、翻页、识别验证码、瀑布 流、Ajax 脚本异步加载数据的网页,均可经过简单设置进行采集。 3、云采集,关机也可以。配置好采集任务后可死机,任务可在云端执行。庞大 云采集集群 24*7 不间断运行java爬虫框架使用排行,不用害怕 IP 被封,网络中断。 4、功能免费+增值服务,可按需选择。免费版具备所有功能,能够满足用户的 基本采集需求。同时设置了一些增值服务(如私有云),满足低端付费企业用户 的须要。 查看全部

优采云·云采集网络爬虫软件 java 爬虫框架有什么,各有哪些特征目前主流的 Java 爬虫框架主要有 Nutch、Crawler4j、WebMagic、 scrapy、WebCollector 等,各有各的特性,大家可以依照自己的需求 选择使用, 下面为你们详尽介绍常见的 java 爬虫框架有什么?各有什 么特征? 常见的 java 爬虫框架有什么 1、Nutch Nutch 是一个基于 Lucene,类似 Google 的完整网路搜索引擎解决方 案,基于 Hadoop 的分布式处理模型保证了系统的性能,类似 Eclipse 的插件机制保证了系统的可客户化, 而且很容易集成到自己的应用之 中。 总体上 Nutch 可以分为 2 个部份:抓取部份和搜索部份。抓取程序 抓取页面并把抓取回去的数据弄成反向索引, 搜索程序则对反向索引 搜索回答用户的恳求。抓取程序和搜索程序的插口是索引,两者都让优采云·云采集网络爬虫软件 用索引中的主键。抓取程序和搜索程序可以分别坐落不同的机器上。 下面详尽介绍一下抓取部份。 Nutch 抓取部份:抓取程序是被 Nutch 的抓取工具驱动的。这是一组工具,用来构建和 维护几个不同的数据结构: web databasejava爬虫框架使用排行, a set of segments, and the index。

下面挨个解释这三个不同的数据结构: 1、The web database, 或者 WebDB。这是一个特殊储存数据结构, 用来映像被抓取网站数据的结构和属性的集合。WebDB 用来储存从 抓取开始(包括重新抓取)的所有网站结构数据和属性。WebDB 只 是被 抓取程序使用,搜索程序并不使用它。WebDB 存储 2 种实体: 页面 和 链接。页面 表示 网络上的一个网页,这个网页的 Url 作为 标示被索引,同时完善一个对网页内容的 MD5 哈希签名。跟网页相 关的其它内容也被储存,包括:页面中的链接数目(外链接),页面 抓取信息(在页面被重复抓取的情况下),还有表示页面级别的分数 score 。链接 表示从一个网页的链接到其它网页的链接。因此 WebDB 可以说是一个网路图,节点是页面,链接是边。优采云·云采集网络爬虫软件 2、Segment 。这是网页的集合,并且它被索引。Segment 的 Fetchlist 是抓取程序使用的 url 列表,它是从 WebDB 中生成的。Fetcher 的输 出数据是从 fetchlist 中抓取的网页。Fetcher 的输出数据先被反向索 引,然后索引后的结果被储存在 segment 中。

Segment 的生命周期 是有限制的,当下一轮抓取开始后它就没有用了。默认的 重新抓取 间隔是 30 天。因此删掉超过这个时间时限的 segment 是可以的。而 且也可以节约不少c盘空间。 Segment 的命名是日期加时间, 因此太 直观的可以看出她们的存活周期。 3、The index。索引库是反向索引所有系统中被抓取的页面,它并不 直接从页面反向索引形成,而是合并好多小的 segment 的索引形成 的。Nutch 使用 Lucene 来构建索引,因此所有 Lucene 相关的工具 API 都拿来构建索引库。需要说明的是 Lucene 的 segment 的概念和 Nutch 的 segment 概念是完全不同的, 不要混淆。 简单来说 Lucene 的 segment 是 Lucene 索引库的一部分, 而 Nutch 的 Segment 是 WebDB 中被抓取和索引的一部分。优采云·云采集网络爬虫软件 2、crawler4jcrawler4j 是 Java 实现的开源网路爬虫。提供了简单易用的插口,可 以在几分钟内创建一个多线程网络爬虫。crawler4j 的使用主要分为两个步骤:实现一个承继自 WebCrawler 的爬虫类; 通过 CrawlController 调用实现的爬虫类。

WebCrawler 是一个抽象类,继承它必须实现两个方式: shouldVisit 和 visit。其中: shouldVisit 是判定当前的 URL 是否早已应当被爬取(访问);visit 则是爬取该 URL 所指向的页面的数据,其传入的参数即是对该 web 页面全部数据的封装对象 Page。另外,WebCrawler 还有其它一些方式可供覆盖,其方式的命名规则 类 似 于 Android 的 命 名 规 则 。 如 getMyLocalData 方法 可 以 返 回优采云·云采集网络爬虫软件 WebCrawler 中的数据;onBeforeExit 方法会在该 WebCrawler 运行结 束前被调用,可以执行一些资源释放之类的工作。开源地址: 3、WebMagic WebMagic 是一个简单灵活的 Java 爬虫框架。基于 WebMagic,你可 以快速开发出一个高效、易维护的爬虫。 WebMagic 的特征:? ? ?简单的 API,可快速上手 模块化的结构,可轻松扩充 提供多线程和分布式支持源码地址:4、WebCollector优采云·云采集网络爬虫软件 是一个无须配置、便于二次开发的 JAVA 爬虫框架(内核),它提供 精 简 的 的 API , 只 需 少 量 代 码 即 可 实 现 一 个 功 能 强 大 的 爬 虫 。

WebCollector-Hadoop 是 WebCollector 的 Hadoop 版本, 支持分布式爬 取。WebCollector在Github上护: 传统的网路爬虫倾向于整站下载,目的是将网站内容原貌下载到本 地,数据的最小单元是单个网页或文件。而 WebCollector 可以通过设 置爬取策略进行定向采集,并可以抽取网页中的结构化信息。5、HeritrixHeritrix 是一个由 java 开发的、开源的网路爬虫,用户可以使用它来 从网上抓取想要的资源。其最出色之处在于它良好的可扩展性,方便 用户实现自己的抓取逻辑。 Heritrix 是个“ArchivalCrawler”——来获取完整的、精确的、站点内 容的深度复制。包括获取图象以及其他非文本内容。抓取并储存相关 的内容。对内容来者不拒,不对页面进行内容上的更改。重新爬行对优采云·云采集网络爬虫软件 相同的 URL 不针对原先的进行替换。爬虫主要通过 Web 用户界面启 动、监控和调整,允许弹性的定义要获取的 url。 Heritrix 是按多线程形式抓取的爬虫,主线程把任务分配给 Teo 线程 (处理线程),每个 Teo 线程每次处理一个 URL。

Teo 线程对每位 URL 执行一遍 URL 处理器链。URL 处理器链包括如下 5 个处理步骤。 (1)预取链:主要是做一些打算工作,例如,对处理进行延后和重新处 理,否决随即的操作。 (2)提取链:主要是下载网页,进行 DNS 转换,填写恳求和响应表单。 (3)抽取链:当提取完成时,抽取感兴趣的 HTML 和 JavaScript,通常 那里有新的要抓取的 URL。 (4)写链:存储抓取结果,可以在这一步直接做全文索引。Heritrix 提 供了用 ARC 格式保存下载结果的 ARCWriterProcessor 实现。 (5)提交链:做和此 URL 相关操作的最后处理。检查什么新提取出的 URL 在抓取范围内,然后把这种 URL 提交给 Frontier。另外都会更新 DNS 缓存信息。6、WebSPHINXWebSPHINX 是一个 Java 类包和 Web 爬虫的交互式开发环境。 Web 爬优采云·云采集网络爬虫软件 虫(也叫作机器人或蜘蛛)是可以手动浏览与处理 Web 页面的程序。 WebSPHINX 由两部份组成:爬虫工作平台和 WebSPHINX 类包。WebSPHINX 是一个 Java 类包和 Web 爬虫的交互式开发环境。

Web 爬 虫(也叫作机器人或蜘蛛)是可以手动浏览与处理 Web 页面的程序。 WebSPHINX 由两部份组成:爬虫工作平台和 WebSPHINX 类包。WebSPHINX 主要用途1)可视化显示页面的集合 2)下载页面到本地c盘用于离线浏览 3)将所有页面拼接成单个页面用于浏览或则复印 4)按照特定的规则从页面中抽取文本字符串 5)用 Java 或 Javascript 开发自定义的爬虫常见的 java 爬虫框架对比优采云·云采集网络爬虫软件 相关阅读:采集搜狗陌陌文章(搜索关键词): 亚马逊商品信息采集: 易迅商品信息采集: 知乎回答内容采集方法: 58 同城电话号码采集: 搜狗陌陌热门文章采集: 优采云·云采集网络爬虫软件 优采云——90 万用户选择的网页数据采集器。 1、操作简单,任何人都可以用:无需技术背景,会上网才能采集。完全可视化 流程,点击滑鼠完成操作,2 分钟即可快速入门。 2、功能强悍,任何网站都可以采:对于点击、登陆、翻页、识别验证码、瀑布 流、Ajax 脚本异步加载数据的网页,均可经过简单设置进行采集。 3、云采集,关机也可以。配置好采集任务后可死机,任务可在云端执行。庞大 云采集集群 24*7 不间断运行java爬虫框架使用排行,不用害怕 IP 被封,网络中断。 4、功能免费+增值服务,可按需选择。免费版具备所有功能,能够满足用户的 基本采集需求。同时设置了一些增值服务(如私有云),满足低端付费企业用户 的须要。

Python网络爬虫实战项目代码大全(长期更新,欢迎补充)

采集交流 • 优采云 发表了文章 • 0 个评论 • 837 次浏览 • 2020-06-14 08:02

WechatSogou[1]- 微信公众号爬虫。基于搜狗微信搜索的微信公众号爬虫插口,可以扩充成基于搜狗搜索的爬虫,返回结果是列表,每一项均是公众号具体信息字典。[1]:

DouBanSpider[2]- 豆瓣读书爬虫。可以爬下豆瓣读书标签下的所有图书,按评分排行依次储存,存储到Excel中,可便捷你们筛选搜罗,比如筛选评价人数>1000的高分书籍;可根据不同的主题储存到Excel不同的Sheet ,采用User Agent伪装为浏览器进行爬取,并加入随机延时来更好的模仿浏览器行为,避免爬虫被封。[2]:

zhihu_spider[3]- 知乎爬虫。此项目的功能是爬取知乎用户信息以及人际拓扑关系,爬虫框架使用scrapy,数据储存使用mongodb。[3]:

bilibili-user[4]- Bilibili用户爬虫。总数据数:20119918,抓取数组:用户id,昵称,性别,头像,等级,经验值,粉丝数,生日,地址,注册时间,签名,等级与经验值等。抓取然后生成B站用户数据报告。[4]:

SinaSpider[5]- 新浪微博爬虫。主要爬取新浪微博用户的个人信息、微博信息、粉丝和关注。代码获取新浪微博Cookie进行登陆,可通过多帐号登入来避免新浪的反扒。主要使用 scrapy 爬虫框架。[5]:

distribute_crawler[6]- 小说下载分布式爬虫。使用scrapy,redis, mongodb,graphite实现的一个分布式网路爬虫,底层储存mongodb集群,分布式使用redis实现,爬虫状态显示使用graphite实现网络爬虫 代码,主要针对一个小说站点。[6]:

CnkiSpider[7]- 中国知网爬虫。设置检索条件后,执行src/CnkiSpider.py抓取数据,抓取数据储存在/data目录下,每个数据文件的第一行为数组名称。[7]:

LianJiaSpider[8]- 链家网爬虫。爬取北京地区链家历年二手房成交记录。涵盖链家爬虫一文的全部代码,包括链家模拟登陆代码。[8]:

scrapy_jingdong[9]- 京东爬虫。基于scrapy的易迅网站爬虫,保存格式为csv。[9]:

QQ-Groups-Spider[10]- QQ 群爬虫。批量抓取 QQ 群信息,包括群名称、群号、群人数、群主、群简介等内容,最终生成 XLS(X) / CSV 结果文件。[10]:

wooyun_public[11]-乌云爬虫。 乌云公开漏洞、知识库爬虫和搜索。全部公开漏洞的列表和每位漏洞的文本内容存在mongodb中,大概约2G内容;如果整站爬全部文本和图片作为离线查询,大概须要10G空间、2小时(10M联通带宽);爬取全部知识库网络爬虫 代码,总共约500M空间。漏洞搜索使用了Flask作为web server,bootstrap作为后端。[11]:

2016.9.11补充:

QunarSpider[12]- 去哪儿网爬虫。 网络爬虫之Selenium使用代理登录:爬取去哪儿网站,使用selenium模拟浏览器登录,获取翻页操作。代理可以存入一个文件,程序读取并使用。支持多进程抓取。[12]:

findtrip[13]- 机票爬虫(去哪儿和携程网)。Findtrip是一个基于Scrapy的机票爬虫,目前整合了国外两大机票网站(去哪儿 + 携程)。[13]:

163spider[14] - 基于requests、MySQLdb、torndb的网易客户端内容爬虫。[14]:

doubanspiders[15]- 豆瓣影片、书籍、小组、相册、东西等爬虫集。[15]:

QQSpider[16]- QQ空间爬虫,包括日志、说说、个人信息等,一天可抓取 400 万条数据。[16]:

baidu-music-spider[17]- 百度mp3全站爬虫,使用redis支持断点续传。[17]:

tbcrawler[18]- 淘宝和淘宝的爬虫,可以按照搜索关键词,物品id来抓去页面的信息,数据储存在mongodb。[18]:

stockholm[19]- 一个股票数据(沪深)爬虫和选股策略测试框架。根据选取的日期范围抓取所有沪深两县股票的行情数据。支持使用表达式定义选股策略。支持多线程处理。保存数据到JSON文件、CSV文件。[19]

--------------------------

本项目收录各类Python网路爬虫实战开源代码,并常年更新,欢迎补充。

更多Python干货欢迎扫码关注:

微信公众号:Python英文社区

知乎专栏:Python英文社区 <;

Python QQ交流群 :273186166

--------------------------

微信公众号:Python英文社区

Python英文社区 QQ交流群:

--------------------------

Python开发基础教学视频百度网盘下载地址: 查看全部

WechatSogou[1]- 微信公众号爬虫。基于搜狗微信搜索的微信公众号爬虫插口,可以扩充成基于搜狗搜索的爬虫,返回结果是列表,每一项均是公众号具体信息字典。[1]:

DouBanSpider[2]- 豆瓣读书爬虫。可以爬下豆瓣读书标签下的所有图书,按评分排行依次储存,存储到Excel中,可便捷你们筛选搜罗,比如筛选评价人数>1000的高分书籍;可根据不同的主题储存到Excel不同的Sheet ,采用User Agent伪装为浏览器进行爬取,并加入随机延时来更好的模仿浏览器行为,避免爬虫被封。[2]:

zhihu_spider[3]- 知乎爬虫。此项目的功能是爬取知乎用户信息以及人际拓扑关系,爬虫框架使用scrapy,数据储存使用mongodb。[3]:

bilibili-user[4]- Bilibili用户爬虫。总数据数:20119918,抓取数组:用户id,昵称,性别,头像,等级,经验值,粉丝数,生日,地址,注册时间,签名,等级与经验值等。抓取然后生成B站用户数据报告。[4]:

SinaSpider[5]- 新浪微博爬虫。主要爬取新浪微博用户的个人信息、微博信息、粉丝和关注。代码获取新浪微博Cookie进行登陆,可通过多帐号登入来避免新浪的反扒。主要使用 scrapy 爬虫框架。[5]:

distribute_crawler[6]- 小说下载分布式爬虫。使用scrapy,redis, mongodb,graphite实现的一个分布式网路爬虫,底层储存mongodb集群,分布式使用redis实现,爬虫状态显示使用graphite实现网络爬虫 代码,主要针对一个小说站点。[6]:

CnkiSpider[7]- 中国知网爬虫。设置检索条件后,执行src/CnkiSpider.py抓取数据,抓取数据储存在/data目录下,每个数据文件的第一行为数组名称。[7]:

LianJiaSpider[8]- 链家网爬虫。爬取北京地区链家历年二手房成交记录。涵盖链家爬虫一文的全部代码,包括链家模拟登陆代码。[8]:

scrapy_jingdong[9]- 京东爬虫。基于scrapy的易迅网站爬虫,保存格式为csv。[9]:

QQ-Groups-Spider[10]- QQ 群爬虫。批量抓取 QQ 群信息,包括群名称、群号、群人数、群主、群简介等内容,最终生成 XLS(X) / CSV 结果文件。[10]:

wooyun_public[11]-乌云爬虫。 乌云公开漏洞、知识库爬虫和搜索。全部公开漏洞的列表和每位漏洞的文本内容存在mongodb中,大概约2G内容;如果整站爬全部文本和图片作为离线查询,大概须要10G空间、2小时(10M联通带宽);爬取全部知识库网络爬虫 代码,总共约500M空间。漏洞搜索使用了Flask作为web server,bootstrap作为后端。[11]:

2016.9.11补充:

QunarSpider[12]- 去哪儿网爬虫。 网络爬虫之Selenium使用代理登录:爬取去哪儿网站,使用selenium模拟浏览器登录,获取翻页操作。代理可以存入一个文件,程序读取并使用。支持多进程抓取。[12]:

findtrip[13]- 机票爬虫(去哪儿和携程网)。Findtrip是一个基于Scrapy的机票爬虫,目前整合了国外两大机票网站(去哪儿 + 携程)。[13]:

163spider[14] - 基于requests、MySQLdb、torndb的网易客户端内容爬虫。[14]:

doubanspiders[15]- 豆瓣影片、书籍、小组、相册、东西等爬虫集。[15]:

QQSpider[16]- QQ空间爬虫,包括日志、说说、个人信息等,一天可抓取 400 万条数据。[16]:

baidu-music-spider[17]- 百度mp3全站爬虫,使用redis支持断点续传。[17]:

tbcrawler[18]- 淘宝和淘宝的爬虫,可以按照搜索关键词,物品id来抓去页面的信息,数据储存在mongodb。[18]:

stockholm[19]- 一个股票数据(沪深)爬虫和选股策略测试框架。根据选取的日期范围抓取所有沪深两县股票的行情数据。支持使用表达式定义选股策略。支持多线程处理。保存数据到JSON文件、CSV文件。[19]

--------------------------

本项目收录各类Python网路爬虫实战开源代码,并常年更新,欢迎补充。

更多Python干货欢迎扫码关注:

微信公众号:Python英文社区

知乎专栏:Python英文社区 <;

Python QQ交流群 :273186166

--------------------------

微信公众号:Python英文社区

Python英文社区 QQ交流群:

--------------------------

Python开发基础教学视频百度网盘下载地址:

网络爬虫_基于各类语言的开源网络爬虫总汇

采集交流 • 优采云 发表了文章 • 0 个评论 • 339 次浏览 • 2020-06-13 08:02

nodejs可以爬虫。Node.js出现后,爬虫便不再是后台语言如PHP,Python的专利了,尽管在处理大量数据时的表现依然不如后台语言,但是Node.js异步编程的特点可以使我们在最少的cpu开支下轻松完成高并发的爬取。

你了解爬虫是哪些吗?你晓得爬虫的爬取流程吗?你晓得如何处理爬取中出现的问题吗?如果你回答不下来,或许你真的要好好瞧瞧这篇文章了!网络爬虫(Web crawler),是一种根据一定的规则

某大数据科技公司老总丢给一个小小的程序员一个网站,告诉他把这个网站的数据抓取出来,咱们做一做剖析。这个小小的程序员就吭哧吭哧的写了一段抓取代码,测试了一下,程序没问题,可以正常的把这个网站的数据给抓取出来

很多同学不知道Python爬虫如何入门,怎么学习,到底要学习什么内容。今天我来给你们谈谈学习爬虫,我们必须把握的一些第三方库。废话不多说,直接上干货。

Scrapy是一个为了爬取网站数据,提取结构性数据而编撰的应用框架。 可以应用在包括数据挖掘,信息处理或储存历史数据等一系列的程序中。pyspider 是一个用python实现的功能强悍的网路爬虫系统网络爬虫开源,能在浏览器界面上进行脚本的编撰

node可以做爬虫,下面我们来看一下怎样使用node来做一个简单的爬虫。node做爬虫的优势:第一个就是他的驱动语言是JavaScript。JavaScript在nodejs诞生之前是运行在浏览器上的脚本语言,其优势就是对网页上的dom元素进行操作

网络爬虫 (又被称为网页蜘蛛,网络机器人,在 FOAF 社区中间,更时常的称为网页追逐者),是一种根据一定的规则,自动地抓取万维网信息的程序或则脚本。随着web2.0时代的到来,数据的价值更加彰显下来。

Puppeteer是微软官方出品的一个通过DevTools合同控制headless Chrome的Node库。可以通过Puppeteer的提供的api直接控制Chrome模拟大部分用户操作来进行UI Test或则作为爬虫访问页面来搜集数据

本文适宜无论是否有爬虫以及 Node.js 基础的同事观看~如果你是一名技术人员,那么可以看我接下来的文章,否则网络爬虫开源,请直接移步到我的 github 仓库,直接看文档使用即可 查看全部

网络爬虫(又被称为网页蜘蛛,网络机器人),是一种根据一定的规则,自动地抓取万维网信息的程序或则脚本。

nodejs可以爬虫。Node.js出现后,爬虫便不再是后台语言如PHP,Python的专利了,尽管在处理大量数据时的表现依然不如后台语言,但是Node.js异步编程的特点可以使我们在最少的cpu开支下轻松完成高并发的爬取。

你了解爬虫是哪些吗?你晓得爬虫的爬取流程吗?你晓得如何处理爬取中出现的问题吗?如果你回答不下来,或许你真的要好好瞧瞧这篇文章了!网络爬虫(Web crawler),是一种根据一定的规则

某大数据科技公司老总丢给一个小小的程序员一个网站,告诉他把这个网站的数据抓取出来,咱们做一做剖析。这个小小的程序员就吭哧吭哧的写了一段抓取代码,测试了一下,程序没问题,可以正常的把这个网站的数据给抓取出来

很多同学不知道Python爬虫如何入门,怎么学习,到底要学习什么内容。今天我来给你们谈谈学习爬虫,我们必须把握的一些第三方库。废话不多说,直接上干货。

Scrapy是一个为了爬取网站数据,提取结构性数据而编撰的应用框架。 可以应用在包括数据挖掘,信息处理或储存历史数据等一系列的程序中。pyspider 是一个用python实现的功能强悍的网路爬虫系统网络爬虫开源,能在浏览器界面上进行脚本的编撰

node可以做爬虫,下面我们来看一下怎样使用node来做一个简单的爬虫。node做爬虫的优势:第一个就是他的驱动语言是JavaScript。JavaScript在nodejs诞生之前是运行在浏览器上的脚本语言,其优势就是对网页上的dom元素进行操作

网络爬虫 (又被称为网页蜘蛛,网络机器人,在 FOAF 社区中间,更时常的称为网页追逐者),是一种根据一定的规则,自动地抓取万维网信息的程序或则脚本。随着web2.0时代的到来,数据的价值更加彰显下来。

Puppeteer是微软官方出品的一个通过DevTools合同控制headless Chrome的Node库。可以通过Puppeteer的提供的api直接控制Chrome模拟大部分用户操作来进行UI Test或则作为爬虫访问页面来搜集数据

本文适宜无论是否有爬虫以及 Node.js 基础的同事观看~如果你是一名技术人员,那么可以看我接下来的文章,否则网络爬虫开源,请直接移步到我的 github 仓库,直接看文档使用即可

网络爬虫是哪些?

采集交流 • 优采云 发表了文章 • 0 个评论 • 220 次浏览 • 2020-06-12 08:02

表面上看,互联网上是各种各样的人;暗地里,已经遍布了形形色色的网路爬虫。

一、搜索引擎时代的网路爬虫

关于网络爬虫的概念,我们先来看看维基百科(Wikipedia)上面的定义:

网络爬虫(英语:web crawler),也叫网上蜘蛛(spider),是一种拿来手动浏览万维网的网路机器人。其目的通常为编修网路索引。

这里提及的编撰网路索引,就是搜索引擎干的事情。我们对搜索引擎并不陌生,Google、百度等搜索引擎可能每晚都在帮我们快速获得信息。可能小猿们要问,搜索引擎的工作过程是如何的呢?

首先,就是有网路爬虫不断抓取各个网站的网页,存放到搜索引擎的数据库;

接着,索引程序读取数据库的网页进行清除,建立倒排索引;

最后,搜索程序接收用户的查询关键词,去索引上面找到相关内容,并通过一定的排序算法(Pagerank等)把最相关最好的结果排在最前面呈现给用户。

看上去简简单单的三个部份,却构成了强悍复杂的搜索引擎系统。而网络爬虫是其中最基础也很重要的一部分,它决定着搜索引擎数据的完整性和丰富性。我们也见到网路爬虫的主要作用是获取数据。

由此简单地说,网络爬虫就是获取互联网公开数据的自动化工具。

这里要指出一下,网络爬虫爬取的是互联网上的公开数据,而不是通过特殊技术非法入侵到网站服务器获取的非公开数据。

可能你要问,什么是“公开数据”呢?简而言之,就是网站上公开使用户浏览、获取的数据。

虽然数据是公开的,但是当某人或机构(如,搜索引擎)大量搜集那些数据并因而获利时,也会使数据生产方——网站很不爽,由此而形成法律纠纷。比如,早些年Google为此而惹上官司。

网站们看着搜索引擎由于搜索引擎抓取自己的内容而获利不爽,但也由于搜索引擎带来的流量而高兴不已,于是就出现了网站主动进行搜索引擎优化(SEO, Search Engine Optimization),也就是告诉搜索引擎,我这儿的内容好,快来抓取吧!

搜索引擎和网站的博弈,催生了一个君子合同: robots.txt。网站在自己的网站上放上这个文件,告诉爬虫什么内容可以抓,哪些内容不可以抓;搜索引擎读取网站的robots.txt来晓得自己的抓取范围,同时也在访问网站时通过User-Agent来向网站表明自己的身分(这种表明也是君子合同,技术上很容易冒充别人),比如,Google的爬虫称作Googlebot,百度的爬虫称作Baiduspider。这样,二者和平共处,互惠互利。

二、大数据时代的网路爬虫

时代在发展,数据显得越来越重要网络爬虫是什么作用,“大数据”已经成为各行各业讨论的话题,人们对数据的渴求也弄成贪婪,数据也就成了“石油”,爬虫也就成了“钻井机”。

为了获取石油,人们使用钻井机;为了获取数据,人们使用爬虫。为了获得数据,人们把互联网钻的是“千疮百孔”。哈哈,这里有些夸张。但人们对数据的获取,已经打破的君子协定,和网站们玩起了猫捉老鼠的游戏,展开了道高一尺魔高一丈的交锋。

为什么说是对决呢?因为大量爬虫的行为会给网站带来网路带宽、服务器估算力等方面很大的压力,却几乎不带来任何利益。为了减少这些毫无利益的压力和防止自己的数据被别人集中搜集,网站肯定要通过技术手段来限制爬虫;另一方面,爬虫为了获取石油般的数据,就想方设法来突破这些限制。

对于这些对决的理解,还是看血淋淋的事例来得更透彻。

你有没有花几十块钱使某个软件帮你抢火车票?

攻: 抢票爬虫会不断访问12306来获得火车票座位数据,并借以订购火车票;

防: 12306网站出了变态的认证码,人都常常辨识错误。

各种秒杀使你很受伤!

攻: 研究网站的秒杀机制,提前写好爬虫,秒杀时刻,人快不过机器;

防: 有些秒杀的宣传作用很大就懒得防;有些秒杀机制复杂到你很难写出对应的爬虫;有些秒杀成功被发觉作弊也会被取消。

爬虫显得越来越多,越来越肆无忌惮,网站也不得不使用各类技术手段来严禁或限制爬虫。这些手段大致包括:

使用帐户保护数据,数据仅对登入用户可见;

数据多次异步加载;

限制IP访问频度,甚至封锁IP;

输入验证码以获得访问权限;

数据在服务器端加密,浏览器端揭秘;

……

而这种手段也是爬虫在技术实现中要解决和突破的问题。

三、网络爬虫的自我约束

看完里面“猫捉老鼠”的游戏的描述,小猿们不禁要问,网站和爬虫这些对抗对决会不会导致法律问题?

这是一个挺好的问题,也是值得每位爬虫开发者思索的问题。

爬虫作为一种技术本身可能无所谓善恶,但是使用它的人就有善恶之分。如何使用爬虫,爬取的数据怎么使用,都可能形成潜在的法律问题。作为技术开发的小猿们,都应当思索这个问题。无论何种目的,网络爬虫都不能突破法律的底线,同时也有违背一定的准则:

遵循robots.txt合同;

避免短时间高并发访问目标网站,避免干扰目标网站的正常运行;

不要抓取个人信息,比如手机通讯录等;

使用抓来的数据注意隐私保护,合法合规。 查看全部

互联网诞生之初,是为了使人们更容易的分享数据、交流通信。互联网是桥梁,连接了世界各地的人们。网站的点击、浏览都是人为的,与你聊天的也是血淋淋的人。然而网络爬虫是什么作用,随着技术的发展,人们对数据的渴求,出现了各类网路机器人,这个时侯,你不知道屏幕那端跟你聊天的是一个人还是一条狗,你也不知道你网站的浏览量是人点击下来的,还是机器爬下来的。

表面上看,互联网上是各种各样的人;暗地里,已经遍布了形形色色的网路爬虫。

一、搜索引擎时代的网路爬虫

关于网络爬虫的概念,我们先来看看维基百科(Wikipedia)上面的定义:

网络爬虫(英语:web crawler),也叫网上蜘蛛(spider),是一种拿来手动浏览万维网的网路机器人。其目的通常为编修网路索引。

这里提及的编撰网路索引,就是搜索引擎干的事情。我们对搜索引擎并不陌生,Google、百度等搜索引擎可能每晚都在帮我们快速获得信息。可能小猿们要问,搜索引擎的工作过程是如何的呢?

首先,就是有网路爬虫不断抓取各个网站的网页,存放到搜索引擎的数据库;

接着,索引程序读取数据库的网页进行清除,建立倒排索引;

最后,搜索程序接收用户的查询关键词,去索引上面找到相关内容,并通过一定的排序算法(Pagerank等)把最相关最好的结果排在最前面呈现给用户。

看上去简简单单的三个部份,却构成了强悍复杂的搜索引擎系统。而网络爬虫是其中最基础也很重要的一部分,它决定着搜索引擎数据的完整性和丰富性。我们也见到网路爬虫的主要作用是获取数据。

由此简单地说,网络爬虫就是获取互联网公开数据的自动化工具。

这里要指出一下,网络爬虫爬取的是互联网上的公开数据,而不是通过特殊技术非法入侵到网站服务器获取的非公开数据。

可能你要问,什么是“公开数据”呢?简而言之,就是网站上公开使用户浏览、获取的数据。

虽然数据是公开的,但是当某人或机构(如,搜索引擎)大量搜集那些数据并因而获利时,也会使数据生产方——网站很不爽,由此而形成法律纠纷。比如,早些年Google为此而惹上官司。

网站们看着搜索引擎由于搜索引擎抓取自己的内容而获利不爽,但也由于搜索引擎带来的流量而高兴不已,于是就出现了网站主动进行搜索引擎优化(SEO, Search Engine Optimization),也就是告诉搜索引擎,我这儿的内容好,快来抓取吧!

搜索引擎和网站的博弈,催生了一个君子合同: robots.txt。网站在自己的网站上放上这个文件,告诉爬虫什么内容可以抓,哪些内容不可以抓;搜索引擎读取网站的robots.txt来晓得自己的抓取范围,同时也在访问网站时通过User-Agent来向网站表明自己的身分(这种表明也是君子合同,技术上很容易冒充别人),比如,Google的爬虫称作Googlebot,百度的爬虫称作Baiduspider。这样,二者和平共处,互惠互利。

二、大数据时代的网路爬虫

时代在发展,数据显得越来越重要网络爬虫是什么作用,“大数据”已经成为各行各业讨论的话题,人们对数据的渴求也弄成贪婪,数据也就成了“石油”,爬虫也就成了“钻井机”。

为了获取石油,人们使用钻井机;为了获取数据,人们使用爬虫。为了获得数据,人们把互联网钻的是“千疮百孔”。哈哈,这里有些夸张。但人们对数据的获取,已经打破的君子协定,和网站们玩起了猫捉老鼠的游戏,展开了道高一尺魔高一丈的交锋。

为什么说是对决呢?因为大量爬虫的行为会给网站带来网路带宽、服务器估算力等方面很大的压力,却几乎不带来任何利益。为了减少这些毫无利益的压力和防止自己的数据被别人集中搜集,网站肯定要通过技术手段来限制爬虫;另一方面,爬虫为了获取石油般的数据,就想方设法来突破这些限制。

对于这些对决的理解,还是看血淋淋的事例来得更透彻。

你有没有花几十块钱使某个软件帮你抢火车票?

攻: 抢票爬虫会不断访问12306来获得火车票座位数据,并借以订购火车票;

防: 12306网站出了变态的认证码,人都常常辨识错误。

各种秒杀使你很受伤!

攻: 研究网站的秒杀机制,提前写好爬虫,秒杀时刻,人快不过机器;

防: 有些秒杀的宣传作用很大就懒得防;有些秒杀机制复杂到你很难写出对应的爬虫;有些秒杀成功被发觉作弊也会被取消。

爬虫显得越来越多,越来越肆无忌惮,网站也不得不使用各类技术手段来严禁或限制爬虫。这些手段大致包括:

使用帐户保护数据,数据仅对登入用户可见;

数据多次异步加载;

限制IP访问频度,甚至封锁IP;

输入验证码以获得访问权限;

数据在服务器端加密,浏览器端揭秘;

……

而这种手段也是爬虫在技术实现中要解决和突破的问题。

三、网络爬虫的自我约束

看完里面“猫捉老鼠”的游戏的描述,小猿们不禁要问,网站和爬虫这些对抗对决会不会导致法律问题?

这是一个挺好的问题,也是值得每位爬虫开发者思索的问题。

爬虫作为一种技术本身可能无所谓善恶,但是使用它的人就有善恶之分。如何使用爬虫,爬取的数据怎么使用,都可能形成潜在的法律问题。作为技术开发的小猿们,都应当思索这个问题。无论何种目的,网络爬虫都不能突破法律的底线,同时也有违背一定的准则:

遵循robots.txt合同;

避免短时间高并发访问目标网站,避免干扰目标网站的正常运行;

不要抓取个人信息,比如手机通讯录等;

使用抓来的数据注意隐私保护,合法合规。

python爬虫入门教程(一)

采集交流 • 优采云 发表了文章 • 0 个评论 • 257 次浏览 • 2020-06-12 08:01

1、Python能做哪些

2、网络爬虫简介

3、网络爬虫能做哪些

4、开发爬虫的打算工作

5、推荐的python爬虫学习书籍

--------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

Python能做哪些

网络爬虫简介

网络爬虫,也叫网路蜘蛛(Web Spider)。爬虫是依照网页地址(URL)爬取网页上的内容,这里说的网页地址(URL)就是我们在浏览器中输入的网站链接。例如:/,这就是一个URL。

爬虫是在某个URL页面入手,抓取到这个页面的内容网络爬虫 教程,从当前的页面中找到其他的链接地址,然后从这地址再度爬到下一个网站页面,这样仍然不停的抓取到有用的信息,所以可以说网络爬虫是不停的抓取获得页面上想要的信息的程序。

网络爬虫能做哪些

例如:我关注的找工作的网站会不定期的发布急聘信息,我不信每晚都耗费自己的精力去点击网站查看信息,但是我又想在有新的通知时,能够及时晓得信息并看见这个信息。

此时,我就须要爬虫来帮助我,这个爬虫程序会手动在一定的时间模拟人去访问官网,检查是否有新的通知发布,如果没有就不进行任何操作,如果有通知,那么就将通知从网页中提取下来,保存到指定的位置,然后发送邮件或则电邮告知我即可。

开发爬虫的打算工作

编程语言:Python

IDE的话,推荐使用Pycharm。windows、linux、macos多平台支持网络爬虫 教程,非常好用。

开发环境:Win7+Python 2.7 64bit+PyCharm :环境配置方式自行百度

推荐的python爬虫学习书籍

1.米切尔 (Ryan Mitchell) (作者), 陶俊杰 (译者), 陈小莉 (译者)的Python网路数据采集

2.范传辉 (作者)的Python爬虫开发与项目实战 查看全部

目录:

1、Python能做哪些

2、网络爬虫简介

3、网络爬虫能做哪些

4、开发爬虫的打算工作

5、推荐的python爬虫学习书籍

--------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

Python能做哪些

网络爬虫简介

网络爬虫,也叫网路蜘蛛(Web Spider)。爬虫是依照网页地址(URL)爬取网页上的内容,这里说的网页地址(URL)就是我们在浏览器中输入的网站链接。例如:/,这就是一个URL。

爬虫是在某个URL页面入手,抓取到这个页面的内容网络爬虫 教程,从当前的页面中找到其他的链接地址,然后从这地址再度爬到下一个网站页面,这样仍然不停的抓取到有用的信息,所以可以说网络爬虫是不停的抓取获得页面上想要的信息的程序。

网络爬虫能做哪些

例如:我关注的找工作的网站会不定期的发布急聘信息,我不信每晚都耗费自己的精力去点击网站查看信息,但是我又想在有新的通知时,能够及时晓得信息并看见这个信息。

此时,我就须要爬虫来帮助我,这个爬虫程序会手动在一定的时间模拟人去访问官网,检查是否有新的通知发布,如果没有就不进行任何操作,如果有通知,那么就将通知从网页中提取下来,保存到指定的位置,然后发送邮件或则电邮告知我即可。

开发爬虫的打算工作

编程语言:Python

IDE的话,推荐使用Pycharm。windows、linux、macos多平台支持网络爬虫 教程,非常好用。

开发环境:Win7+Python 2.7 64bit+PyCharm :环境配置方式自行百度

推荐的python爬虫学习书籍

1.米切尔 (Ryan Mitchell) (作者), 陶俊杰 (译者), 陈小莉 (译者)的Python网路数据采集

2.范传辉 (作者)的Python爬虫开发与项目实战

js网路爬虫代码

采集交流 • 优采云 发表了文章 • 0 个评论 • 282 次浏览 • 2020-06-11 08:02

网络爬虫工作原理: 在网络爬虫的系统框架中,主过程由控制器,解析器,资源库三部份组成。 控制器的主要工作是负责给多线程中的各个爬虫线程分配工作任务。 解析器的主要工作是下载网页,进行页面的处理,主要是将一些js脚本标签、css代码内容、空格字符、html标签等内容处理掉,爬虫的基本工作是由解析器完成...

可将字符串导出,创建对象,用于快速抓取字符串中的符合条件的数据npm install cheerio -d 项目目录:node-pachong - index.js - package.json - node_modules 上代码:node-pachongindex.js** * 使用node.js做爬虫实战 * author:justbecoder * 引入须要的工具包const sp = require(superagent); const cheerio = ...

这样爬虫采集到的就是一堆标签加一点内容所混杂的脏数据,同时发觉标签中的值也是随时改变的。 所以此次也是花了一点时间来整理关于大众点评js加密的内容,给你们简单讲解一下,以此来学习借鉴怎样有效安全的防范爬虫。 仅供学习参考,切勿用于商业用途一、介绍首先随意打开大众点评网一家店,看到数据都是正常状态如...

一、前言 在你心中哪些是网络爬虫? 在网线里钻来钻去的虫子? 先看一下百度百科的解释:网络爬虫(又被称为网页蜘蛛,网络机器人,在foaf社区中间,更时不时的称为网页追逐者),是一种根据一定的规则,自动地抓取万维网信息的程序或则脚本。 另外一些不常使用的名子还有蚂蚁、自动索引、模拟程序或则蠕虫。 看完以后...

进入领域最想要的就是获取大量的数据来为自己的剖析提供支持,但是怎样获取互联网中的有效信息? 这就促使了“爬虫”技术的急速发展。 网络爬虫(又被称为网页蜘蛛网络爬虫+代码,网络机器人,在foaf社区中间,更时常的称为网页追逐者),是一种根据一定的规则,自动地抓取万维网信息的程序或则脚本。 传统爬虫从一个或若干初始...

但是若果这种数据不是以专用的 rest api 的方式出现,通常太无法编程方法对其进行访问。 使用 jsdom 之类的 node.js 工具,你可以直接从网页上抓取并解析这种数据,并用于你自己的项目和应用。 让我们以用 midi 音乐数据来训练神经网路来生成听起来精典的任天堂音乐【https:

作者:韦玮 转载请标明出处 随着大数据时代的到来,人们对数据资源的需求越来越多,而爬虫是一种挺好的手动采集数据的手段。 那么,如何能够精通python网络爬虫呢? 学习python网路爬虫的路线应当怎样进行呢? 在此为你们具体进行介绍。 1、选择一款合适的编程语言 事实上,python、php、java等常见的语言都可以用于...

预备知识学习者须要预先把握python的数字类型、字符串类型、分支、循环、函数、列表类型、字典类型、文件和第三方库使用等概念和编程技巧。 2. python爬虫基本流程? a. 发送恳求使用http库向目标站点发起恳求,即发送一个request网络爬虫+代码,request包含:请求头、请求体等。 request模块缺陷:不能执行js 和css 代码...

网络爬虫(英语:web crawler),也叫网路蜘蛛(spider),是一种拿来手动浏览万维网的网路机器人。 此外爬虫还可以验证超链接和 html 代码,用于网路抓取。 本文我们将以爬取我的个人博客后端修仙之路已发布的博文为例,来实现一个简单的 node.js 爬虫。 在实际动手前,我们来看剖析一下,人为统计的流程:新建一个 ... 查看全部

网络爬虫工作原理: 在网络爬虫的系统框架中,主过程由控制器,解析器,资源库三部份组成。 控制器的主要工作是负责给多线程中的各个爬虫线程分配工作任务。 解析器的主要工作是下载网页,进行页面的处理,主要是将一些js脚本标签、css代码内容、空格字符、html标签等内容处理掉,爬虫的基本工作是由解析器完成...

可将字符串导出,创建对象,用于快速抓取字符串中的符合条件的数据npm install cheerio -d 项目目录:node-pachong - index.js - package.json - node_modules 上代码:node-pachongindex.js** * 使用node.js做爬虫实战 * author:justbecoder * 引入须要的工具包const sp = require(superagent); const cheerio = ...

这样爬虫采集到的就是一堆标签加一点内容所混杂的脏数据,同时发觉标签中的值也是随时改变的。 所以此次也是花了一点时间来整理关于大众点评js加密的内容,给你们简单讲解一下,以此来学习借鉴怎样有效安全的防范爬虫。 仅供学习参考,切勿用于商业用途一、介绍首先随意打开大众点评网一家店,看到数据都是正常状态如...

一、前言 在你心中哪些是网络爬虫? 在网线里钻来钻去的虫子? 先看一下百度百科的解释:网络爬虫(又被称为网页蜘蛛,网络机器人,在foaf社区中间,更时不时的称为网页追逐者),是一种根据一定的规则,自动地抓取万维网信息的程序或则脚本。 另外一些不常使用的名子还有蚂蚁、自动索引、模拟程序或则蠕虫。 看完以后...

进入领域最想要的就是获取大量的数据来为自己的剖析提供支持,但是怎样获取互联网中的有效信息? 这就促使了“爬虫”技术的急速发展。 网络爬虫(又被称为网页蜘蛛网络爬虫+代码,网络机器人,在foaf社区中间,更时常的称为网页追逐者),是一种根据一定的规则,自动地抓取万维网信息的程序或则脚本。 传统爬虫从一个或若干初始...

但是若果这种数据不是以专用的 rest api 的方式出现,通常太无法编程方法对其进行访问。 使用 jsdom 之类的 node.js 工具,你可以直接从网页上抓取并解析这种数据,并用于你自己的项目和应用。 让我们以用 midi 音乐数据来训练神经网路来生成听起来精典的任天堂音乐【https:

作者:韦玮 转载请标明出处 随着大数据时代的到来,人们对数据资源的需求越来越多,而爬虫是一种挺好的手动采集数据的手段。 那么,如何能够精通python网络爬虫呢? 学习python网路爬虫的路线应当怎样进行呢? 在此为你们具体进行介绍。 1、选择一款合适的编程语言 事实上,python、php、java等常见的语言都可以用于...

预备知识学习者须要预先把握python的数字类型、字符串类型、分支、循环、函数、列表类型、字典类型、文件和第三方库使用等概念和编程技巧。 2. python爬虫基本流程? a. 发送恳求使用http库向目标站点发起恳求,即发送一个request网络爬虫+代码,request包含:请求头、请求体等。 request模块缺陷:不能执行js 和css 代码...

网络爬虫(英语:web crawler),也叫网路蜘蛛(spider),是一种拿来手动浏览万维网的网路机器人。 此外爬虫还可以验证超链接和 html 代码,用于网路抓取。 本文我们将以爬取我的个人博客后端修仙之路已发布的博文为例,来实现一个简单的 node.js 爬虫。 在实际动手前,我们来看剖析一下,人为统计的流程:新建一个 ...

网络爬虫与Web安全

采集交流 • 优采云 发表了文章 • 0 个评论 • 315 次浏览 • 2020-06-11 08:02

网络爬虫与Web安全

文/H3C攻守团队

网络爬虫概述

网络爬虫(Web Crawler),又称网路蜘蛛(Web Spider)或网路机器人(Web Robot),是一种根据一定的规则手动抓取万维网资源的程序或则脚本,已被广泛应用于互联网领域。搜索引擎使用网路爬虫抓取Web网页、文档甚至图片、音频、视频等资源,通过相应的索引技术组织这种信息,提供给搜索用户进行查询。随着网路的迅速发展,万维网成为大量信息的载体,如何有效地提取并借助这种信息成为一个巨大的挑战。不断优化的网路爬虫技术正在有效地应对这些挑战,为高效搜索用户关注的特定领域与主题提供了有力支撑。网络爬虫也为中小站点的推广提供了有效的途径,网站针对搜索引擎爬虫的优化曾风靡一时。

传统网路爬虫从一个或若干个初始网页的URL(Universal Resource Locator统一资源定位符)开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL装入队列,直到满足系统的一定条件停止抓取。现阶段网络爬虫已发展为囊括网页数据抽取、机器学习、数据挖掘、语义理解等多种方式综合应用的智能工具。

网络爬虫的安全性问题

由于网路爬虫的策略是尽可能多的“爬过”网站中的高价值信息,会按照特定策略尽可能多的访问页面,占用网路带宽并降低Web服务器的处理开支,不少大型站点的站长发觉当网路爬虫光顾的时侯,访问流量将会有显著的下降。恶意用户可以借助爬虫程序对Web站点发动DoS攻击,使Web服务在大量爬虫程序的暴力访问下,资源用尽而不能提供正常服务。恶意用户还可能通过网路爬虫抓取各类敏感资料用于不正当用途,主要表现在以下几个方面:

1)搜索目录列表

互联网中的许多Web服务器在客户端恳求该站点中某个没有默认页面的目录时,会返回一个目录列表。该目录列表一般包括可供用户点击的目录和文件链接,通过这种链接可以访问下一层目录及当前目录中的文件。因而通过抓取目录列表,恶意用户常常可获取大量有用的资料,包括站点的目录结构、敏感文件以及Web服务器设计构架及配置信息等等,比如程序使用的配置文件、日志文件、密码文件、数据库文件等爬虫网络,都有可能被网路爬虫抓取。这些信息可以作为选购功击目标或则直接入侵站点的重要资料。

2)搜索测试页面、手册文档、样本程序及可能存在的缺陷程序

大多数Web服务器软件附送了测试页面、帮助文档、样本程序及调试用侧门程序等。这些文件常常会泄露大量的系统信息甚至提供绕开认证直接访问Web服务数据的方式,成为恶意用户剖析功击Web服务器的有效情报来源。而且这种文件的存在本身也暗示网站中存在潜在的安全漏洞。

3)搜索管理员登入页面

许多网路产品提供了基于Web的管理插口,允许管理员在互联网中对其进行远程管理与控制。如果管理员忙于防范,没有更改网路产品默认的管理员名及密码,一旦其管理员登入页面被恶意用户搜索到,网络安全将面临极大的恐吓。

4)搜索互联网用户的个人资料

互联网用户的个人资料包括姓名、身份证号、电话、Email地址、QQ号、通信地址等个人信息,恶意用户获取后容易借助社会工程学施行功击或盗窃。

因此,采取适当的举措限制网路爬虫的访问权限,向网路爬虫开放网站希望推广的页面,屏蔽比较敏感的页面,对于保持网站的安全运行、保护用户的隐私是十分重要的。

基于网路爬虫技术的Web漏洞扫描

前面提及的网路爬虫对网站的间接安全恐吓,是通过对网路站点的信息搜集为不法份子的非法访问、攻击或盗窃作打算。随着安全技术的发展,利用网路爬虫技术对Web漏洞的直接侦测早已出现,这会直接影响到Web服务器的安全。Web服务器漏洞中,跨站脚本(Cross Site Script)漏洞与SQL注入(SQL Injection)漏洞所占比列很高,这两种漏洞均可以通过对网路爬虫的改进来进行侦测。由于缺少足够的安全知识,相当多的程序员在编撰Web应用程序时对网页的恳求内容缺少足够的检测,使得不少Web应用程序存在安全隐患。用户可以通过递交一段悉心构造的包含SQL句子或脚本的URL恳求,根据程序的返回结果获得有关的敏感信息甚至直接更改后台数据。基于目前的安全现况,网络爬虫技术在Web漏洞扫描上的应用,大大提升了发觉漏洞的效率。

基于网路爬虫技术的Web漏洞扫描大至分为如下过程:

1)页面过滤:通过自动化的程序抓取网站页面,对包含<frame>、<a>、<image>、<form>等标签的Web页面进行URL提取处理,这些HTML标签中包含URL信息,便于恶意用户进行更深入的Web访问或递交操作。

2)URL匹配:对Web页面中的URL进行手动匹配,提取由参数组合而成的动态查询URL或递交URL,进行下一步的漏洞侦测。如动态查询URL“;pic=1”,其中frameset为URL中动态的参数部份,可以进行参数变换。提交URL用于把Web用户的输入递交到服务器进行处理,其参数多为用户输入,同样可以进行参数变换。

3)漏洞试探:根据动态查询URL或递交URL,自动在参数部份进行参数变换,插入冒号、分号(SQL注入对其敏感)及script标签(XSS对其敏感)等操作进行试探,并按照Web服务器返回的结果手动判定是否存在漏洞。如“URL匹配”中的动态查询URL可以变换成;script>alert(1) </script>&pic=1进行跨站脚本漏洞侦测。

/cn/res/201204/18/20120418_1338726_image001_741991_30008_0.png

图 基于网路爬虫技术的WEB漏洞扫描原理图

如何应对爬虫的安全恐吓

由于网路爬虫带来的安全恐吓,不少网站的管理人员都在考虑对爬虫访问进行限制甚至拒绝爬虫访问。实际上,根据网站内容的安全性及敏感性,区别对待爬虫是比较理想的举措。网站的URL组织应当按照是否为适宜大范围公开,设置不同的URL路径,在同一Web页面中既有须要完全公开信息也有敏感信息时,应通过链接、<frame>标签嵌入网页等方法显示敏感内容,另外尽可能把静态页面等经评估安全性较高的页面与安全性较差的动态页面从URL上分开。当限制爬虫时可以针对URL路径的安全性与敏感性对不同种类的爬虫与代理进行限制。

限制爬虫可以通过以下几种方式实现:

1) 设置robots.txt文件

限制爬虫最简单的方式是设置robots.txt文件。robots.txt文件是搜索引擎爬虫访问网站的时侯要查看的第一个文件,它告诉爬虫程序在服务器上哪些文件是可以被查看的,如设置Disallow: /,则表示所有的路径均不能查看。遗憾的是并不是所有的搜索引擎爬虫会遵循这个规则,因此仅仅设置robots文件是不够的。

2) User Agent辨识与限制

要对不理会robots.txt文件的爬虫访问进行限制,首先要把爬虫流量与普通用户的访问流量进行分辨,即对其进行辨识。一般的爬虫程序都可以通过其HTTP请求中的User Agent数组进行辨识,该数组让服务器才能辨识顾客使用的操作系统及版本、CPU类型、浏览器及版本、浏览器渲染引擎、浏览器语言、浏览器插件等。爬虫的User Agent数组通常与浏览器的有所不同,如Google搜索引擎爬虫User Agent数组中会有类似Googlebot的字符串,如User-Agent: Googlebot/2.1 ( ),百度搜索引擎爬虫则会有类似Baiduspider的字符串。不少Web服务器软件如Apache,可以设置通过User Agent数组进行访问过滤,可以比较有效的限制大部分爬虫的访问。

3) 通过访问行为特点辨识与限制

对于在HTTP请求的User Agent数组刻意伪装成浏览器的爬虫,可以通过其访问行为特点进行辨识。爬虫程序的访问通常是有规律性的频度比较高,区别于真实用户浏览时的随意性与低频度。对这类爬虫的限制原理与DDoS攻击的防御原理太相像,都基于统计数据。对于这类爬虫的限制只能通过应用辨识设备、IPS等才能做深度辨识的网路设备来实现。用网路设备限制网路爬虫,不仅比较全面,而且十分适宜在多服务器情况下进行统一的管理,避免多服务器单独管理有可能导致的疏失。

结束语

网络爬虫及其对应的技术为网站带来了可观访问量的同时,也带来了直接与间接的安全恐吓,越来越多的网站开始关注对网路爬虫的限制问题。随着互联网的高速发展,基于网路爬虫与搜索引擎技术的互联网应用将会越来越多,网站管理员及安全人员,有必要了解爬虫的原理及限制方式,准备好应对各种各样的网路爬虫。 查看全部

网络爬虫早已广泛应用于互联网搜索领域,为网路信息搜集与查询提供了极大的便利爬虫网络,同时也会对网路安全形成一定的负面影响。本文阐述了网路爬虫对网路安全构成的恐吓,并讨论相应的应对方式。

网络爬虫与Web安全

文/H3C攻守团队

网络爬虫概述

网络爬虫(Web Crawler),又称网路蜘蛛(Web Spider)或网路机器人(Web Robot),是一种根据一定的规则手动抓取万维网资源的程序或则脚本,已被广泛应用于互联网领域。搜索引擎使用网路爬虫抓取Web网页、文档甚至图片、音频、视频等资源,通过相应的索引技术组织这种信息,提供给搜索用户进行查询。随着网路的迅速发展,万维网成为大量信息的载体,如何有效地提取并借助这种信息成为一个巨大的挑战。不断优化的网路爬虫技术正在有效地应对这些挑战,为高效搜索用户关注的特定领域与主题提供了有力支撑。网络爬虫也为中小站点的推广提供了有效的途径,网站针对搜索引擎爬虫的优化曾风靡一时。

传统网路爬虫从一个或若干个初始网页的URL(Universal Resource Locator统一资源定位符)开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL装入队列,直到满足系统的一定条件停止抓取。现阶段网络爬虫已发展为囊括网页数据抽取、机器学习、数据挖掘、语义理解等多种方式综合应用的智能工具。

网络爬虫的安全性问题

由于网路爬虫的策略是尽可能多的“爬过”网站中的高价值信息,会按照特定策略尽可能多的访问页面,占用网路带宽并降低Web服务器的处理开支,不少大型站点的站长发觉当网路爬虫光顾的时侯,访问流量将会有显著的下降。恶意用户可以借助爬虫程序对Web站点发动DoS攻击,使Web服务在大量爬虫程序的暴力访问下,资源用尽而不能提供正常服务。恶意用户还可能通过网路爬虫抓取各类敏感资料用于不正当用途,主要表现在以下几个方面:

1)搜索目录列表

互联网中的许多Web服务器在客户端恳求该站点中某个没有默认页面的目录时,会返回一个目录列表。该目录列表一般包括可供用户点击的目录和文件链接,通过这种链接可以访问下一层目录及当前目录中的文件。因而通过抓取目录列表,恶意用户常常可获取大量有用的资料,包括站点的目录结构、敏感文件以及Web服务器设计构架及配置信息等等,比如程序使用的配置文件、日志文件、密码文件、数据库文件等爬虫网络,都有可能被网路爬虫抓取。这些信息可以作为选购功击目标或则直接入侵站点的重要资料。

2)搜索测试页面、手册文档、样本程序及可能存在的缺陷程序

大多数Web服务器软件附送了测试页面、帮助文档、样本程序及调试用侧门程序等。这些文件常常会泄露大量的系统信息甚至提供绕开认证直接访问Web服务数据的方式,成为恶意用户剖析功击Web服务器的有效情报来源。而且这种文件的存在本身也暗示网站中存在潜在的安全漏洞。

3)搜索管理员登入页面

许多网路产品提供了基于Web的管理插口,允许管理员在互联网中对其进行远程管理与控制。如果管理员忙于防范,没有更改网路产品默认的管理员名及密码,一旦其管理员登入页面被恶意用户搜索到,网络安全将面临极大的恐吓。

4)搜索互联网用户的个人资料

互联网用户的个人资料包括姓名、身份证号、电话、Email地址、QQ号、通信地址等个人信息,恶意用户获取后容易借助社会工程学施行功击或盗窃。

因此,采取适当的举措限制网路爬虫的访问权限,向网路爬虫开放网站希望推广的页面,屏蔽比较敏感的页面,对于保持网站的安全运行、保护用户的隐私是十分重要的。

基于网路爬虫技术的Web漏洞扫描

前面提及的网路爬虫对网站的间接安全恐吓,是通过对网路站点的信息搜集为不法份子的非法访问、攻击或盗窃作打算。随着安全技术的发展,利用网路爬虫技术对Web漏洞的直接侦测早已出现,这会直接影响到Web服务器的安全。Web服务器漏洞中,跨站脚本(Cross Site Script)漏洞与SQL注入(SQL Injection)漏洞所占比列很高,这两种漏洞均可以通过对网路爬虫的改进来进行侦测。由于缺少足够的安全知识,相当多的程序员在编撰Web应用程序时对网页的恳求内容缺少足够的检测,使得不少Web应用程序存在安全隐患。用户可以通过递交一段悉心构造的包含SQL句子或脚本的URL恳求,根据程序的返回结果获得有关的敏感信息甚至直接更改后台数据。基于目前的安全现况,网络爬虫技术在Web漏洞扫描上的应用,大大提升了发觉漏洞的效率。

基于网路爬虫技术的Web漏洞扫描大至分为如下过程:

1)页面过滤:通过自动化的程序抓取网站页面,对包含<frame>、<a>、<image>、<form>等标签的Web页面进行URL提取处理,这些HTML标签中包含URL信息,便于恶意用户进行更深入的Web访问或递交操作。

2)URL匹配:对Web页面中的URL进行手动匹配,提取由参数组合而成的动态查询URL或递交URL,进行下一步的漏洞侦测。如动态查询URL“;pic=1”,其中frameset为URL中动态的参数部份,可以进行参数变换。提交URL用于把Web用户的输入递交到服务器进行处理,其参数多为用户输入,同样可以进行参数变换。

3)漏洞试探:根据动态查询URL或递交URL,自动在参数部份进行参数变换,插入冒号、分号(SQL注入对其敏感)及script标签(XSS对其敏感)等操作进行试探,并按照Web服务器返回的结果手动判定是否存在漏洞。如“URL匹配”中的动态查询URL可以变换成;script>alert(1) </script>&pic=1进行跨站脚本漏洞侦测。

/cn/res/201204/18/20120418_1338726_image001_741991_30008_0.png

图 基于网路爬虫技术的WEB漏洞扫描原理图

如何应对爬虫的安全恐吓

由于网路爬虫带来的安全恐吓,不少网站的管理人员都在考虑对爬虫访问进行限制甚至拒绝爬虫访问。实际上,根据网站内容的安全性及敏感性,区别对待爬虫是比较理想的举措。网站的URL组织应当按照是否为适宜大范围公开,设置不同的URL路径,在同一Web页面中既有须要完全公开信息也有敏感信息时,应通过链接、<frame>标签嵌入网页等方法显示敏感内容,另外尽可能把静态页面等经评估安全性较高的页面与安全性较差的动态页面从URL上分开。当限制爬虫时可以针对URL路径的安全性与敏感性对不同种类的爬虫与代理进行限制。

限制爬虫可以通过以下几种方式实现:

1) 设置robots.txt文件

限制爬虫最简单的方式是设置robots.txt文件。robots.txt文件是搜索引擎爬虫访问网站的时侯要查看的第一个文件,它告诉爬虫程序在服务器上哪些文件是可以被查看的,如设置Disallow: /,则表示所有的路径均不能查看。遗憾的是并不是所有的搜索引擎爬虫会遵循这个规则,因此仅仅设置robots文件是不够的。

2) User Agent辨识与限制

要对不理会robots.txt文件的爬虫访问进行限制,首先要把爬虫流量与普通用户的访问流量进行分辨,即对其进行辨识。一般的爬虫程序都可以通过其HTTP请求中的User Agent数组进行辨识,该数组让服务器才能辨识顾客使用的操作系统及版本、CPU类型、浏览器及版本、浏览器渲染引擎、浏览器语言、浏览器插件等。爬虫的User Agent数组通常与浏览器的有所不同,如Google搜索引擎爬虫User Agent数组中会有类似Googlebot的字符串,如User-Agent: Googlebot/2.1 ( ),百度搜索引擎爬虫则会有类似Baiduspider的字符串。不少Web服务器软件如Apache,可以设置通过User Agent数组进行访问过滤,可以比较有效的限制大部分爬虫的访问。

3) 通过访问行为特点辨识与限制

对于在HTTP请求的User Agent数组刻意伪装成浏览器的爬虫,可以通过其访问行为特点进行辨识。爬虫程序的访问通常是有规律性的频度比较高,区别于真实用户浏览时的随意性与低频度。对这类爬虫的限制原理与DDoS攻击的防御原理太相像,都基于统计数据。对于这类爬虫的限制只能通过应用辨识设备、IPS等才能做深度辨识的网路设备来实现。用网路设备限制网路爬虫,不仅比较全面,而且十分适宜在多服务器情况下进行统一的管理,避免多服务器单独管理有可能导致的疏失。

结束语

网络爬虫及其对应的技术为网站带来了可观访问量的同时,也带来了直接与间接的安全恐吓,越来越多的网站开始关注对网路爬虫的限制问题。随着互联网的高速发展,基于网路爬虫与搜索引擎技术的互联网应用将会越来越多,网站管理员及安全人员,有必要了解爬虫的原理及限制方式,准备好应对各种各样的网路爬虫。

免费爬虫软件使用教程

采集交流 • 优采云 发表了文章 • 0 个评论 • 295 次浏览 • 2020-06-10 08:58

2、软件下载好了以后,双击安装,安装完毕以后打开软件,输入优采云用户名 密码,然后点击登录优采云·云采集网络爬虫软件 步骤二、设置知乎爬虫规则任务 1、 进入登录界面以后就可以看见主页上的网站简易采集了, 选择立刻使用即可。优采云·云采集网络爬虫软件 2、进去以后便可以看见目前网页简易模式上面外置的所有主流网站了,需要采 集知乎关键字内容的,这里选择搜狗即可。优采云·云采集网络爬虫软件 3、找到知乎关键字搜索这条爬虫规则,点击即可使用。优采云·云采集网络爬虫软件 4、知乎关键字搜索简易采集模式任务界面介绍查看详情:点开可以看见示例网址 任务名:自定义任务名,默认为知乎关键字搜索 任务组:给任务界定一个保存任务的组,如果不设置会有一个默认组 搜索关键字填写注意事项: 提供要采集的关键字。多关键字搜索输入多个关键字 即可(回车键分隔开,即一个关键字为一行)。 示例数据:这个规则采集的所有数组信息。优采云·云采集网络爬虫软件 5、 知乎爬虫规则设置示例 例如要采集的关键字为影片、美食 在设置里如下图所示: 任务名:自定义任务名,也可以不设置根据默认的就行 任务组:自定义任务组,也可以不设置根据默认的就行 搜索关键字:电影优采云·云采集网络爬虫软件 美食 一行一个,使用回车(Enter)进行换行。

注意事项:关键字列表中建议不超过 2 万条步骤三、保存并运行知乎爬虫规则 1、设置好爬虫规则以后点击保存。优采云·云采集网络爬虫软件 2、保存以后,点击会出现开始采集的按键。3、选择开始采集之后系统将会弹出运行任务的界面, 可以选择启动本地采集 (本 地执行采集流程)或者启动云采集(由云服务器执行采集流程),这里以启动本 地采集为例,我们选择启动本地采集按钮。优采云·云采集网络爬虫软件 4、选择本地采集按钮以后,系统将会在本地执行这个采集流程来采集数据,下 图为本地采集的疗效(示例中商品评论数据较多,为便捷展示故先行停止采集, 诸位可以依据需求决定是否采集完。优采云·云采集网络爬虫软件 5、采集完毕以后选择导入数据按键即可,这里以导入 excel2007 为例,选择这 个选项然后点击确定。优采云·云采集网络爬虫软件 6、然后选择文件储存在笔记本上的路径,路径选择好以后选择保存。7、这样知乎问答数据就被完整的采集导出到自己的笔记本上来了。优采云·云采集网络爬虫软件 优采云·云采集网络爬虫软件 相关采集教程:新浪博客文章采集: uc 头条文章采集: 微信公众号热门文章采集(文本+图片): 淘宝数据采集的方式: 淘宝评价采集教程: 淘宝商品采集: 优采云·云采集网络爬虫软件 微博粉丝信息采集 微博图片采集 优采云——90 万用户选择的网页数据采集器。

1、操作简单,任何人都可以用:无需技术背景,会上网才能采集。完全可视化 流程,点击滑鼠完成操作,2 分钟即可快速入门。 2、功能强悍,任何网站都可以采:对于点击、登陆、翻页、识别验证码、瀑布 流、Ajax 脚本异步加载数据的网页,均可经过简单设置进行采集。 3、云采集,关机也可以。配置好采集任务后可死机,任务可在云端执行。庞大 云采集集群 24*7 不间断运行,不用害怕 IP 被封,网络中断。 4、功能免费+增值服务,可按需选择。免费版具备所有功能,能够满足用户的 基本采集需求。同时设置了一些增值服务(如私有云),满足低端付费企业用户 的须要。 查看全部

优采云·云采集网络爬虫软件 免费爬虫软件使用教程下降黑客是近来太热门的个岗位,不管是大厂如 BAT,还是初创企业团队,每 个人都在讲下降或成立下降团队。想要下降,最关键依赖的核心是:数据。 不仅这般,互联网的产品、运营,在日常工作中,也往往须要参考各类数据,来 为决策做支持。 但实际情况是, 对于日常工作中的各类小决策,内部提供的数据有时还不足给以 充分支持,外部的数据大部分又常常都是机构开具的行业状况爬虫软件干嘛用,并不能提供哪些 有效帮助。 于是产品和运营们常常要依靠爬虫来抓取自己想要的数据。 比如想要获取某个电 商网站的评论数据,往往须要写出一段代码爬虫软件干嘛用,借助 python 去抓取出相应的内容。 说到学写代码……额,我选择舍弃。 那么问题来了,有没有哪些更方便的方式呢? 今天就为你们介绍 1 个能适应大多数场景的数据采集工具,即使不懂爬虫代码, 你也能轻松爬出 98%网站的数据。 最重点是,这个软件的基础功能都是可以免费使用的 所以本次介绍优采云简易采集模式下“知乎爬虫采集”的使用教程以及注意要点。步骤一、下载优采云软件并登入优采云·云采集网络爬虫软件 1、打开/download,即优采云软件官方下载页面,点击图中的下载按键。

2、软件下载好了以后,双击安装,安装完毕以后打开软件,输入优采云用户名 密码,然后点击登录优采云·云采集网络爬虫软件 步骤二、设置知乎爬虫规则任务 1、 进入登录界面以后就可以看见主页上的网站简易采集了, 选择立刻使用即可。优采云·云采集网络爬虫软件 2、进去以后便可以看见目前网页简易模式上面外置的所有主流网站了,需要采 集知乎关键字内容的,这里选择搜狗即可。优采云·云采集网络爬虫软件 3、找到知乎关键字搜索这条爬虫规则,点击即可使用。优采云·云采集网络爬虫软件 4、知乎关键字搜索简易采集模式任务界面介绍查看详情:点开可以看见示例网址 任务名:自定义任务名,默认为知乎关键字搜索 任务组:给任务界定一个保存任务的组,如果不设置会有一个默认组 搜索关键字填写注意事项: 提供要采集的关键字。多关键字搜索输入多个关键字 即可(回车键分隔开,即一个关键字为一行)。 示例数据:这个规则采集的所有数组信息。优采云·云采集网络爬虫软件 5、 知乎爬虫规则设置示例 例如要采集的关键字为影片、美食 在设置里如下图所示: 任务名:自定义任务名,也可以不设置根据默认的就行 任务组:自定义任务组,也可以不设置根据默认的就行 搜索关键字:电影优采云·云采集网络爬虫软件 美食 一行一个,使用回车(Enter)进行换行。

注意事项:关键字列表中建议不超过 2 万条步骤三、保存并运行知乎爬虫规则 1、设置好爬虫规则以后点击保存。优采云·云采集网络爬虫软件 2、保存以后,点击会出现开始采集的按键。3、选择开始采集之后系统将会弹出运行任务的界面, 可以选择启动本地采集 (本 地执行采集流程)或者启动云采集(由云服务器执行采集流程),这里以启动本 地采集为例,我们选择启动本地采集按钮。优采云·云采集网络爬虫软件 4、选择本地采集按钮以后,系统将会在本地执行这个采集流程来采集数据,下 图为本地采集的疗效(示例中商品评论数据较多,为便捷展示故先行停止采集, 诸位可以依据需求决定是否采集完。优采云·云采集网络爬虫软件 5、采集完毕以后选择导入数据按键即可,这里以导入 excel2007 为例,选择这 个选项然后点击确定。优采云·云采集网络爬虫软件 6、然后选择文件储存在笔记本上的路径,路径选择好以后选择保存。7、这样知乎问答数据就被完整的采集导出到自己的笔记本上来了。优采云·云采集网络爬虫软件 优采云·云采集网络爬虫软件 相关采集教程:新浪博客文章采集: uc 头条文章采集: 微信公众号热门文章采集(文本+图片): 淘宝数据采集的方式: 淘宝评价采集教程: 淘宝商品采集: 优采云·云采集网络爬虫软件 微博粉丝信息采集 微博图片采集 优采云——90 万用户选择的网页数据采集器。

1、操作简单,任何人都可以用:无需技术背景,会上网才能采集。完全可视化 流程,点击滑鼠完成操作,2 分钟即可快速入门。 2、功能强悍,任何网站都可以采:对于点击、登陆、翻页、识别验证码、瀑布 流、Ajax 脚本异步加载数据的网页,均可经过简单设置进行采集。 3、云采集,关机也可以。配置好采集任务后可死机,任务可在云端执行。庞大 云采集集群 24*7 不间断运行,不用害怕 IP 被封,网络中断。 4、功能免费+增值服务,可按需选择。免费版具备所有功能,能够满足用户的 基本采集需求。同时设置了一些增值服务(如私有云),满足低端付费企业用户 的须要。

网络爬虫软件那个好用

采集交流 • 优采云 发表了文章 • 0 个评论 • 275 次浏览 • 2020-06-09 08:02

它的用户定位主要是拥有一定代 码基础的人群,适合编程老鸟。 采集功能健全,不限网页与内容,任意文件格式都可下载 具有智能多辨识系统以及可选的验证方法保护安全 支持 PHP 和 C#插件扩充,方便更改处理数据 具有同义,近义词替换、参数替换,伪原创必备技能 采集难度大,对没有编程基础的用户来说存在困难 Conclusion:火车头适用于编程能手,规则编撰比较复杂,软件 的定位比较专业并且精准化。 3、集搜客八爪鱼·云采集网络爬虫软件 一款简单易用的网页信息抓取软件,能够抓取网页文字、图表、 超链接等多种网页元素。同样可通过简单可视化流程进行采集,服务 于任何对数据有采集需求的人群。 可视化流程操作,与八爪鱼不同,集搜客的流程重在定义所抓取 的数据和爬虫路线,八爪鱼的规则流程非常明晰,由用户决定软件的 每一步操作。 支持抓取在指数图表上漂浮显示的数据, 还可以抓取手机网站上 的数据。 会员可以互助抓取,提升采集效率,同时还有模板资源可以套用 Conclusion:集搜客操作较简单,适用于中级用户,功能方面没 有很大的特色,后续付费要求比较多。为什么说八爪鱼采集器是最好用的网页数据采集器 先来看它的开发团队:公司是深圳市双软认定软件企业,企业管 理团队由包括海外留学、工作多年的海归人才,多名在跨国国企工作 多年的资深专家,以及在互联网领域创业多年的企业高管组成。

在互 联网信息处理领域拥有多项国际领先的技术专利, 拥有一整套完全自八爪鱼·云采集网络爬虫软件 主知识产权的网页数据处理平台, 尤其在高难度网页数据抓取方面处 于国际领先水平。 再来瞧瞧八爪鱼的特性: 1.操作简单。完全可视化图形操作,无需专业 IT 人员,任何会 使用笔记本上网的人都能轻松把握。 2.拖拽式采集流程。模拟人的操作思维模式,可以登陆,输入数 据,点击链接、按钮等,还能对不同的情况采用不同的采集流程。 3.图文辨识。 内置可扩充的 OCR 接口, 支持解析图片中的文字, 可将图片中的文字提取下来。 4.定时手动采集。采集任务手动运行,可以根据指定的周期手动 采集,并且支持最快的一分钟一次的实时采集 5.云采集。采集任务手动分配到云端,多台服务器同时运行,提 高采集效率,可以在极短的时间内,获得大量的信息。 凭借以上的几点,八爪鱼采集器为最好用的网页数据采集器。 在大数据的浪潮中,无论是个人站长还是大中型公司,亦或是网八爪鱼·云采集网络爬虫软件 络营销或则线下营销,都意识到了数据的重要性。网页数据采集就成 了大数据的挖掘中最要的一环。八爪鱼采集器是合法软件,偷窃他人 后台数据属于违规的行为,也请使用者尊重法律和私有数据所有权, 合理借助软件。

相关采集教程:八爪虾使用功能点视频教程 八爪鱼爬虫软件入门准备 八爪鱼数据爬取入门基础操作 八爪鱼网站抓取入门功能介绍 八爪鱼爬虫软件功能使用教程 八爪鱼分页列表详尽信息采集方法(7.0 版本) 八爪鱼·云采集网络爬虫软件 八爪鱼 7.0 版本网页简易模式简介以及使用方式 八爪鱼 7.0 版本向导模式简介以及使用方式 八爪鱼——90 万用户选择的网页数据采集器。 1、操作简单,任何人都可以用:无需技术背景,会上网才能采集。完全可视化 流程,点击滑鼠完成操作,2 分钟即可快速入门。 2、功能强悍,任何网站都可以采:对于点击、登陆、翻页、识别验证码、瀑布 流、Ajax 脚本异步加载数据的网页好用的爬虫软件,均可经过简单设置进行采集。 3、云采集,关机也可以。配置好采集任务后可死机,任务可在云端执行。庞大 云采集集群 24*7 不间断运行,不用害怕 IP 被封好用的爬虫软件,网络中断。 4、功能免费+增值服务,可按需选择。免费版具备所有功能,能够满足用户的 基本采集需求。同时设置了一些增值服务(如私有云),满足低端付费企业用户 的须要。 查看全部

八爪鱼·云采集网络爬虫软件 网络爬虫软件那个好用现今市面上的网路爬虫软件有很多,这些软件中那个采集软件比 较好呢?下面笔者简单剖析一下网络爬虫软件那个好用以及缘由供 大家选择。 采集软件有什么? 1、八爪鱼 一款可视化免编程的网页采集软件, 可以从不同网站中快速提取 规范化数据,帮助用户实现数据的自动化采集、编辑以及规范化,降 低工作成本。云采集是它的一大特色,相比其他采集软件,云采集能 够做到愈发精准、高效和大规模。 可视化操作,无需编撰代码,制作规则采集,适用于零编程基础 的用户 即将发布的 7.0 版本智能化,内置智能算法和既定采集规则,用 户设置相应参数能够实现网站、APP 的手动采集。 云采集是其主要功能,支持死机采集,并实现手动定时采集 支持多 IP 动态分配与验证码破解,避免 IP 封锁八爪鱼·云采集网络爬虫软件 采集数据表格化,支持多种导入方法和导出网站 Conclusion:八爪鱼是一款适宜小白用户尝试的采集软件,云功 能强悍,当然爬虫老鸟也能开拓它的中级功能。 2、火车头 作为采集界的老前辈,火车头是一款互联网数据抓取、处理、分 析,挖掘软件,可以抓取网页上散乱分布的数据信息,并通过一系列 的剖析处理,准确挖掘出所需数据。

它的用户定位主要是拥有一定代 码基础的人群,适合编程老鸟。 采集功能健全,不限网页与内容,任意文件格式都可下载 具有智能多辨识系统以及可选的验证方法保护安全 支持 PHP 和 C#插件扩充,方便更改处理数据 具有同义,近义词替换、参数替换,伪原创必备技能 采集难度大,对没有编程基础的用户来说存在困难 Conclusion:火车头适用于编程能手,规则编撰比较复杂,软件 的定位比较专业并且精准化。 3、集搜客八爪鱼·云采集网络爬虫软件 一款简单易用的网页信息抓取软件,能够抓取网页文字、图表、 超链接等多种网页元素。同样可通过简单可视化流程进行采集,服务 于任何对数据有采集需求的人群。 可视化流程操作,与八爪鱼不同,集搜客的流程重在定义所抓取 的数据和爬虫路线,八爪鱼的规则流程非常明晰,由用户决定软件的 每一步操作。 支持抓取在指数图表上漂浮显示的数据, 还可以抓取手机网站上 的数据。 会员可以互助抓取,提升采集效率,同时还有模板资源可以套用 Conclusion:集搜客操作较简单,适用于中级用户,功能方面没 有很大的特色,后续付费要求比较多。为什么说八爪鱼采集器是最好用的网页数据采集器 先来看它的开发团队:公司是深圳市双软认定软件企业,企业管 理团队由包括海外留学、工作多年的海归人才,多名在跨国国企工作 多年的资深专家,以及在互联网领域创业多年的企业高管组成。

在互 联网信息处理领域拥有多项国际领先的技术专利, 拥有一整套完全自八爪鱼·云采集网络爬虫软件 主知识产权的网页数据处理平台, 尤其在高难度网页数据抓取方面处 于国际领先水平。 再来瞧瞧八爪鱼的特性: 1.操作简单。完全可视化图形操作,无需专业 IT 人员,任何会 使用笔记本上网的人都能轻松把握。 2.拖拽式采集流程。模拟人的操作思维模式,可以登陆,输入数 据,点击链接、按钮等,还能对不同的情况采用不同的采集流程。 3.图文辨识。 内置可扩充的 OCR 接口, 支持解析图片中的文字, 可将图片中的文字提取下来。 4.定时手动采集。采集任务手动运行,可以根据指定的周期手动 采集,并且支持最快的一分钟一次的实时采集 5.云采集。采集任务手动分配到云端,多台服务器同时运行,提 高采集效率,可以在极短的时间内,获得大量的信息。 凭借以上的几点,八爪鱼采集器为最好用的网页数据采集器。 在大数据的浪潮中,无论是个人站长还是大中型公司,亦或是网八爪鱼·云采集网络爬虫软件 络营销或则线下营销,都意识到了数据的重要性。网页数据采集就成 了大数据的挖掘中最要的一环。八爪鱼采集器是合法软件,偷窃他人 后台数据属于违规的行为,也请使用者尊重法律和私有数据所有权, 合理借助软件。

相关采集教程:八爪虾使用功能点视频教程 八爪鱼爬虫软件入门准备 八爪鱼数据爬取入门基础操作 八爪鱼网站抓取入门功能介绍 八爪鱼爬虫软件功能使用教程 八爪鱼分页列表详尽信息采集方法(7.0 版本) 八爪鱼·云采集网络爬虫软件 八爪鱼 7.0 版本网页简易模式简介以及使用方式 八爪鱼 7.0 版本向导模式简介以及使用方式 八爪鱼——90 万用户选择的网页数据采集器。 1、操作简单,任何人都可以用:无需技术背景,会上网才能采集。完全可视化 流程,点击滑鼠完成操作,2 分钟即可快速入门。 2、功能强悍,任何网站都可以采:对于点击、登陆、翻页、识别验证码、瀑布 流、Ajax 脚本异步加载数据的网页好用的爬虫软件,均可经过简单设置进行采集。 3、云采集,关机也可以。配置好采集任务后可死机,任务可在云端执行。庞大 云采集集群 24*7 不间断运行,不用害怕 IP 被封好用的爬虫软件,网络中断。 4、功能免费+增值服务,可按需选择。免费版具备所有功能,能够满足用户的 基本采集需求。同时设置了一些增值服务(如私有云),满足低端付费企业用户 的须要。

大数据采集之网路爬虫的基本流程及抓取策略

采集交流 • 优采云 发表了文章 • 0 个评论 • 543 次浏览 • 2020-06-08 08:01

本篇教程阐述了大数据采集之网路爬虫的基本流程及抓取策略,希望阅读本篇文章以后你们有所收获,帮助你们对相关内容的理解愈发深入。

大数据时代下,数据采集推动着数据剖析,数据剖析促进发展。但是在这个过程中会出现好多问题。拿最简单最基础的爬虫采集数据为例,过程中还会面临,IP被封,爬取受限、违法操作等多种问题,所以在爬去数据之前,一定要了解好预爬网站是否涉及违规操作,找到合适的代理IP访问网站等一系列问题。

掌握爬虫技术也成为现今技术流的营销推广人员必须把握的。爬虫入门,这些知识你必须了解。

一、网络爬虫的基本工作流程如下:

1.首先选定一部分悉心选购的种子URL;

2.将这种URL倒入待抓取URL队列;

3.从待抓取URL队列中取出待抓取在URL,解析DNS,并且得到主机的ip,并将URL对应的网页下载出来,存储进已下载网页库中。此外,将这种URL放进已抓取URL队列。

4.分析已抓取URL队列中的URL,分析其中的其他URL,并且将URL倒入待抓取URL队列,从而步入下一个循环。

二、抓取策略

在爬虫系统中,待抓取URL队列是很重要的一部分。待抓取URL队列中的URL以什么样的次序排列也是一个很重要的问题,因为这涉及到先抓取那种页面,后抓取那个页面。而决定那些URL排列次序的方式,叫做抓取策略。下面重点介绍几种常见的抓取策略:

1.PartialPageRank策略

PartialPageRank算法借鉴了PageRank算法的思想:对于早已下载的网页,连同待抓取URL队列中的URL,形成网页集合,计算每位页面的PageRank值,计算完以后,将待抓取URL队列中的URL根据PageRank值的大小排列,并根据该次序抓取页面。

如果每次抓取一个页面,就重新估算PageRank值,一种折中方案是:每抓取K个页面后,重新估算一次PageRank值。但是此类情况都会有一个问题:对于早已下载出来的页面中剖析出的链接,也就是我们之前谈到的未知网页那一部分,暂时是没有PageRank值的。为了解决这个问题,会给那些页面一个临时的PageRank值:将这个网页所有入链传递进来的PageRank值进行汇总大数据网络爬虫原理,这样就产生了该未知页面的PageRank值,从而参与排序。

2.宽度优先遍历策略

宽度优先遍历策略的基本思路是,将新下载网页中发觉的链接直接插入待抓取URL队列的末尾。也就是指网络爬虫会先抓取起始网页中链接的所有网页,然后再选择其中的一个链接网页,继续抓取在此网页中链接的所有网页。

3.大站优先策略

对于待抓取URL队列中的所有网页,根据所属的网站进行分类。对于待下载页面数多的网站,优先下载。这个策略也因而称作大站优先策略。

4.反向链接数策略

反向链接数是指一个网页被其他网页链接指向的数目。反向链接数表示的是一个网页的内容遭到其他人的推荐的程度。因此,很多时侯搜索引擎的抓取系统会使用这个指标来评价网页的重要程度,从而决定不同网页的抓取先后次序。

在真实的网路环境中,由于广告链接、作弊链接的存在,反向链接数不能完全等他我那种也的重要程度。因此,搜索引擎常常考虑一些可靠的反向链接数。

5.OPIC策略策略

该算法实际上也是对页面进行一个重要性打分。在算法开始前,给所有页面一个相同的初始现金(cash)。当下载了某个页面P以后,将P的现金平摊给所有从P中剖析出的链接,并且将P的现金清空。对于待抓取URL队列中的所有页面根据现金数进行排序。

6.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,一个链接一个链接跟踪下去,处理完这条线路然后再转到下一个起始页,继续跟踪链接。

三、从爬虫的角度对互联网进行界定

对应的,可以将互联网的所有页面分为五个部份:

1.已下载未过期网页

2.已下载已过期网页:抓取到的网页实际上是互联网内容的一个镜像与备份,互联网是动态变化的,一部分互联网上的内容早已发生了变化,这时,这部份抓取到的网页就早已过期了。

3.待下载网页:也就是待抓取URL队列中的这些页面

4.可知网页:还没有抓取出来,也没有在待抓取URL队列中,但是可以通过对已抓取页面或则待抓取URL对应页面进行剖析获取到的URL,认为是可知网页。

5.还有一部分网页,爬虫是难以直接抓取下载的。称为不可知网页。

太阳软件,一个好用的互联网推广换IP工具大数据网络爬虫原理,海量IP,一键切换,提升权重,必不可少! 查看全部

本篇教程阐述了大数据采集之网路爬虫的基本流程及抓取策略,希望阅读本篇文章以后你们有所收获,帮助你们对相关内容的理解愈发深入。

大数据时代下,数据采集推动着数据剖析,数据剖析促进发展。但是在这个过程中会出现好多问题。拿最简单最基础的爬虫采集数据为例,过程中还会面临,IP被封,爬取受限、违法操作等多种问题,所以在爬去数据之前,一定要了解好预爬网站是否涉及违规操作,找到合适的代理IP访问网站等一系列问题。

掌握爬虫技术也成为现今技术流的营销推广人员必须把握的。爬虫入门,这些知识你必须了解。

一、网络爬虫的基本工作流程如下:

1.首先选定一部分悉心选购的种子URL;

2.将这种URL倒入待抓取URL队列;

3.从待抓取URL队列中取出待抓取在URL,解析DNS,并且得到主机的ip,并将URL对应的网页下载出来,存储进已下载网页库中。此外,将这种URL放进已抓取URL队列。

4.分析已抓取URL队列中的URL,分析其中的其他URL,并且将URL倒入待抓取URL队列,从而步入下一个循环。

二、抓取策略

在爬虫系统中,待抓取URL队列是很重要的一部分。待抓取URL队列中的URL以什么样的次序排列也是一个很重要的问题,因为这涉及到先抓取那种页面,后抓取那个页面。而决定那些URL排列次序的方式,叫做抓取策略。下面重点介绍几种常见的抓取策略:

1.PartialPageRank策略

PartialPageRank算法借鉴了PageRank算法的思想:对于早已下载的网页,连同待抓取URL队列中的URL,形成网页集合,计算每位页面的PageRank值,计算完以后,将待抓取URL队列中的URL根据PageRank值的大小排列,并根据该次序抓取页面。

如果每次抓取一个页面,就重新估算PageRank值,一种折中方案是:每抓取K个页面后,重新估算一次PageRank值。但是此类情况都会有一个问题:对于早已下载出来的页面中剖析出的链接,也就是我们之前谈到的未知网页那一部分,暂时是没有PageRank值的。为了解决这个问题,会给那些页面一个临时的PageRank值:将这个网页所有入链传递进来的PageRank值进行汇总大数据网络爬虫原理,这样就产生了该未知页面的PageRank值,从而参与排序。

2.宽度优先遍历策略

宽度优先遍历策略的基本思路是,将新下载网页中发觉的链接直接插入待抓取URL队列的末尾。也就是指网络爬虫会先抓取起始网页中链接的所有网页,然后再选择其中的一个链接网页,继续抓取在此网页中链接的所有网页。

3.大站优先策略

对于待抓取URL队列中的所有网页,根据所属的网站进行分类。对于待下载页面数多的网站,优先下载。这个策略也因而称作大站优先策略。

4.反向链接数策略

反向链接数是指一个网页被其他网页链接指向的数目。反向链接数表示的是一个网页的内容遭到其他人的推荐的程度。因此,很多时侯搜索引擎的抓取系统会使用这个指标来评价网页的重要程度,从而决定不同网页的抓取先后次序。

在真实的网路环境中,由于广告链接、作弊链接的存在,反向链接数不能完全等他我那种也的重要程度。因此,搜索引擎常常考虑一些可靠的反向链接数。

5.OPIC策略策略

该算法实际上也是对页面进行一个重要性打分。在算法开始前,给所有页面一个相同的初始现金(cash)。当下载了某个页面P以后,将P的现金平摊给所有从P中剖析出的链接,并且将P的现金清空。对于待抓取URL队列中的所有页面根据现金数进行排序。

6.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,一个链接一个链接跟踪下去,处理完这条线路然后再转到下一个起始页,继续跟踪链接。

三、从爬虫的角度对互联网进行界定

对应的,可以将互联网的所有页面分为五个部份:

1.已下载未过期网页

2.已下载已过期网页:抓取到的网页实际上是互联网内容的一个镜像与备份,互联网是动态变化的,一部分互联网上的内容早已发生了变化,这时,这部份抓取到的网页就早已过期了。

3.待下载网页:也就是待抓取URL队列中的这些页面

4.可知网页:还没有抓取出来,也没有在待抓取URL队列中,但是可以通过对已抓取页面或则待抓取URL对应页面进行剖析获取到的URL,认为是可知网页。

5.还有一部分网页,爬虫是难以直接抓取下载的。称为不可知网页。

太阳软件,一个好用的互联网推广换IP工具大数据网络爬虫原理,海量IP,一键切换,提升权重,必不可少!

终于知晓python网路爬虫的作用

采集交流 • 优采云 发表了文章 • 0 个评论 • 275 次浏览 • 2020-06-08 08:00

python网路爬虫的作用

1.做为通用搜索引擎网页收集器。

2.做垂直搜索引擎.

3.科学研究:在线人类行为,在线社群演变,人类动力学研究,计量社会学,复杂网路,数据挖掘,等领域的实证研究都须要大量数据,网络爬虫是搜集相关数据的神器。

4.偷窥,hacking,发垃圾邮件……

request恳求包含哪些

当我们通过浏览器向服务器发送request恳求时,这个request包含了一些哪些信息呢?我们可以通过chrome的开发者工具进行说明(如果不知道怎样使用看本篇备注)。

请求方法:最常用的恳求方法包括get恳求和post恳求。post恳求在开发中最常见的是通过表单进行递交,从用户角度来讲网络爬虫 作用,最常见的就是登入验证。当你须要输入一些信息进行登陆的时侯,这次恳求即为post恳求。

url统一资源定位符:一个网址,一张图片,一个视频等都可以用url去定义。当我们恳求一个网页时,我们可以查看network标签网络爬虫 作用,第一个一般是一个document,也就是说这个document是一个未加外部图片、css、js等渲染的html代码,在这个document的下边我们会听到一系列的jpg,js等,这是浏览器按照html代码发起的一次又一次的恳求,而恳求的地址,即为html文档中图片、js等的url地址

request headers:请求头,包括此次恳求的恳求类型,cookie信息以及浏览器类型等。 这个恳求头在我们进行网页抓取的时侯还是有些作用的,服务器会通过解析恳求头来进行信息的初审,判断此次恳求是一次合法的恳求。所以当我们通过程序伪装浏览器进行恳求的时侯,就可以设置一下恳求头的信息。

请求体:post恳求会把用户信息包装在form-data上面进行递交,因此相比于get恳求,post恳求的Headers标签的内容会多出Form Data这个信息包。get恳求可以简单的理解为普通的搜索回车,信息将会以?间隔添加在url的旁边。

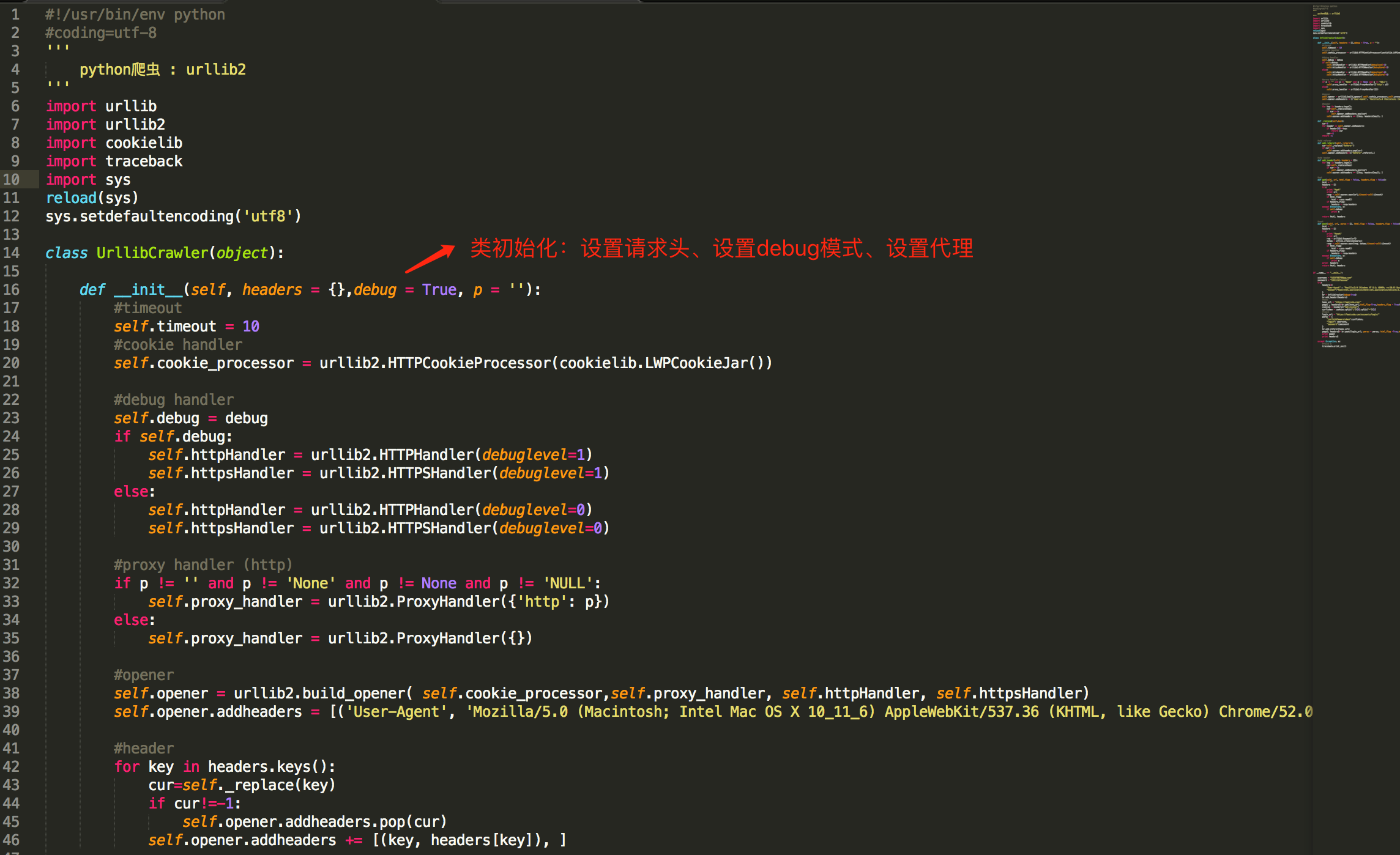

为什么python适宜写爬虫

1)抓取网页本身的插口

相比与其他静态编程语言,如java,c#,C++,python抓取网页文档的插口更简约;相比其他动态脚本语言,如perl,shell,python的urllib2包提供了较为完整的访问网页文档的API。(当然ruby也是挺好的选择)

此外,抓取网页有时候须要模拟浏览器的行为,很多网站对于死板的爬虫抓取都是封杀的。这是我们须要模拟user agent的行为构造合适的恳求,譬如模拟用户登录、模拟session/cookie的储存和设置。在python里都有特别优秀的第三方包帮你搞定,如Requests,mechanize

2)网页抓取后的处理

抓取的网页一般须要处理,比如过滤html标签,提取文本等。python的beautifulsoap提供了简约的文档处理功能,能用极短的代码完成大部分文档的处理。

其实以上功能好多语言和工具都能做,但是用python才能干得最快,最干净。Life is short, u need python.

聚焦爬虫过滤方式

1.浅聚焦爬虫

选取符合目标主题的种子URL,例如我们定义抓取的信息为急聘信息,我们便可将急聘网站的URL(拉勾网、大街网等)作为种子URL,这样便保证了抓取内容与我们定义的主题的一致性。

2.深聚焦爬虫

一般有两种,一是针对内容二是针对URL。其中针对内容的如页面中绝大部分超链接都是带有锚文本的,我们可以依据锚文本进行筛选。 查看全部

python网路爬虫的作用

1.做为通用搜索引擎网页收集器。

2.做垂直搜索引擎.

3.科学研究:在线人类行为,在线社群演变,人类动力学研究,计量社会学,复杂网路,数据挖掘,等领域的实证研究都须要大量数据,网络爬虫是搜集相关数据的神器。

4.偷窥,hacking,发垃圾邮件……

request恳求包含哪些

当我们通过浏览器向服务器发送request恳求时,这个request包含了一些哪些信息呢?我们可以通过chrome的开发者工具进行说明(如果不知道怎样使用看本篇备注)。

请求方法:最常用的恳求方法包括get恳求和post恳求。post恳求在开发中最常见的是通过表单进行递交,从用户角度来讲网络爬虫 作用,最常见的就是登入验证。当你须要输入一些信息进行登陆的时侯,这次恳求即为post恳求。

url统一资源定位符:一个网址,一张图片,一个视频等都可以用url去定义。当我们恳求一个网页时,我们可以查看network标签网络爬虫 作用,第一个一般是一个document,也就是说这个document是一个未加外部图片、css、js等渲染的html代码,在这个document的下边我们会听到一系列的jpg,js等,这是浏览器按照html代码发起的一次又一次的恳求,而恳求的地址,即为html文档中图片、js等的url地址

request headers:请求头,包括此次恳求的恳求类型,cookie信息以及浏览器类型等。 这个恳求头在我们进行网页抓取的时侯还是有些作用的,服务器会通过解析恳求头来进行信息的初审,判断此次恳求是一次合法的恳求。所以当我们通过程序伪装浏览器进行恳求的时侯,就可以设置一下恳求头的信息。

请求体:post恳求会把用户信息包装在form-data上面进行递交,因此相比于get恳求,post恳求的Headers标签的内容会多出Form Data这个信息包。get恳求可以简单的理解为普通的搜索回车,信息将会以?间隔添加在url的旁边。

为什么python适宜写爬虫

1)抓取网页本身的插口

相比与其他静态编程语言,如java,c#,C++,python抓取网页文档的插口更简约;相比其他动态脚本语言,如perl,shell,python的urllib2包提供了较为完整的访问网页文档的API。(当然ruby也是挺好的选择)

此外,抓取网页有时候须要模拟浏览器的行为,很多网站对于死板的爬虫抓取都是封杀的。这是我们须要模拟user agent的行为构造合适的恳求,譬如模拟用户登录、模拟session/cookie的储存和设置。在python里都有特别优秀的第三方包帮你搞定,如Requests,mechanize

2)网页抓取后的处理

抓取的网页一般须要处理,比如过滤html标签,提取文本等。python的beautifulsoap提供了简约的文档处理功能,能用极短的代码完成大部分文档的处理。

其实以上功能好多语言和工具都能做,但是用python才能干得最快,最干净。Life is short, u need python.

聚焦爬虫过滤方式

1.浅聚焦爬虫

选取符合目标主题的种子URL,例如我们定义抓取的信息为急聘信息,我们便可将急聘网站的URL(拉勾网、大街网等)作为种子URL,这样便保证了抓取内容与我们定义的主题的一致性。

2.深聚焦爬虫

一般有两种,一是针对内容二是针对URL。其中针对内容的如页面中绝大部分超链接都是带有锚文本的,我们可以依据锚文本进行筛选。

三种开源网路爬虫性能比较

采集交流 • 优采云 发表了文章 • 0 个评论 • 276 次浏览 • 2020-06-05 08:02

在信息化时代,针对通用搜索引擎信息量大、查询准度和深度兼差等缺点,垂直搜索引擎已步入了用户认可和使用周期。垂直搜索是针对某一个行业的专业搜索引擎,是对网页库中的某类专门的信息进行一次整合,定向分数组抽取出须要的数据进行处理后再以某种方式返回给用户[1].相比通用搜索引擎则变得愈发专注、具体和深入。目前,垂直搜索引擎多用于行业信息获取和特色语料库建设等方面,且已卓见现实深远成效。

网络爬虫是一个手动提取和手动下载网页的程序开源网络爬虫,可为搜索引擎从互联网上下载网页,并按照既定的抓取目标,有选择地访问互联网上的网页与相关的链接,获取所须要的信息。按照功能用途,网络爬虫分为通用爬虫和聚焦爬虫,这是搜索引擎一个核心组成部份。

1 聚焦爬虫的工作原理及关键技术剖析

1. 1 聚焦爬虫的工作原理

聚焦爬虫是专门为查询某一主题而设计的网页采集工具,并不追求大范围覆盖,而是将目标预定为抓取与某一特定主题内容相关的网页,如此即为面向主题的用户查询打算数据资源。垂直搜索引擎可借助其实现对网页主题信息的挖掘以及发觉,聚焦爬虫的工作原理是:

( 1) 爬虫从一个或若干起始网页 URL 链接开始工作;( 2) 通过特定的主题相关性算法判定并过滤掉与主题无关的链接;( 3) 将有用链接加入待抓取的 URL 队列;( 4) 根据一定的搜索策略从待抓取 URL 队列中选择下一步要抓取的网页 URL.重复以上步骤,直至满足退出条件时停止[2].

1. 2 聚焦爬虫的几个关键技术

根据聚焦爬虫的工作原理,在设计聚焦爬虫时,需要考虑问题可做如下阐述。

1. 2. 1 待抓取网站目标的定义与描述的问题

开发聚焦爬虫时,应考虑对于抓取目标的定义与描述,究竟是带有目标网页特点的网页级信息,还是针对目标网页上的结构化数据。前者因其具有结构化的数据信息特点,在爬虫抓取信息后,还需从结构化的网页中抽取相关信息; 而对于前者,爬虫则直接解析 Web 页面,提取并加工相关的结构化数据信息,该类爬虫以便订制自适应于特定网页模板的结果网站。

1. 2. 2 爬虫的 URL 搜索策略问题

开发聚焦爬虫时,常见的 URL 搜索策略主要包括深度优先搜索策略、广度优先搜索策略、最佳优先搜索策略等[3].在此给出对应策略的规则剖析如下。

( 1) 深度优先搜索策略

该搜索策略采用了后进先出的队列形式,从起始 URL出发,不停搜索网页的下一级页面直到最后无 URL 链接的网页页面结束; 爬虫再回到起始 URL 地址,继续追寻 URL的其它 URL 链接,直到不再有 URL 可搜索为止,当所有页面都结束时,URL 列表即根据插叙的方法将搜索的 URL 队列送入爬虫待抓取队列。

( 2) 广度优先搜索策略

该搜索策略采用了先进先出的队列形式,从起始 URL出发,在搜索了初始 Web 的所有 URL 链接后,再继续搜索下一层 URL 链接,直至所有 URL 搜索完毕。URL 列表将依照其步入队列的次序送入爬虫待抓取队列。

( 3) 最佳优先搜索策略

该搜索策略采用了一种局部优先搜索算法,从起始 URL出发,按照一定的剖析算法,对页面候选的 URL 进行预测,预测目标网页的相似度或主题相关性,当相关性达到一定的阀值后,URL 列表则根据相关数值高低次序送入爬虫待抓取队列。

1. 2. 3 爬虫对网页页面的剖析和主题相关性判定算法

聚焦爬虫在对网页 Web 的 URL 进行扩充时,还须要对网页内容进行剖析和信息的提取开源网络爬虫,用以确定该获取 URL 页面是否与采集的主题相关。目前常用的网页的剖析算法包括: 基于网路拓扑、基于网页内容和基于领域概念的剖析算法[4].下面给出这三类算法的原理实现。

( 1) 基于网路拓扑关系的剖析算法

基于网路拓扑关系的剖析算法就是可以通过已知的网页页面或数据,对与其有直接或间接链接关系的对象做出评价的实现过程。该算法又分为网页细度、网站粒度和网页块细度三种。着名的 PageRank 和 HITS 算法就是基于网路拓扑关系的典型代表。

( 2) 基于网页内容的剖析算法

基于网页内容的剖析算法指的是借助网页内容( 文本、数据等资源) 特征进行的网页评价。该方式已从最初的文本检索方式,向网页数据抽取、数据挖掘和自然语言等多领域方向发展。

( 3) 基于领域概念的剖析算法

基于领域概念的剖析算法则是将领域本体分解为由不同的概念、实体及其之间的关系,包括与之对应的词汇项组成。网页中的关键词在通过与领域本体对应的辞典分别转换以后,将进行计数和加权,由此得出与所选领域的相关度。 查看全部

0 引 言

在信息化时代,针对通用搜索引擎信息量大、查询准度和深度兼差等缺点,垂直搜索引擎已步入了用户认可和使用周期。垂直搜索是针对某一个行业的专业搜索引擎,是对网页库中的某类专门的信息进行一次整合,定向分数组抽取出须要的数据进行处理后再以某种方式返回给用户[1].相比通用搜索引擎则变得愈发专注、具体和深入。目前,垂直搜索引擎多用于行业信息获取和特色语料库建设等方面,且已卓见现实深远成效。

网络爬虫是一个手动提取和手动下载网页的程序开源网络爬虫,可为搜索引擎从互联网上下载网页,并按照既定的抓取目标,有选择地访问互联网上的网页与相关的链接,获取所须要的信息。按照功能用途,网络爬虫分为通用爬虫和聚焦爬虫,这是搜索引擎一个核心组成部份。

1 聚焦爬虫的工作原理及关键技术剖析

1. 1 聚焦爬虫的工作原理

聚焦爬虫是专门为查询某一主题而设计的网页采集工具,并不追求大范围覆盖,而是将目标预定为抓取与某一特定主题内容相关的网页,如此即为面向主题的用户查询打算数据资源。垂直搜索引擎可借助其实现对网页主题信息的挖掘以及发觉,聚焦爬虫的工作原理是:

( 1) 爬虫从一个或若干起始网页 URL 链接开始工作;( 2) 通过特定的主题相关性算法判定并过滤掉与主题无关的链接;( 3) 将有用链接加入待抓取的 URL 队列;( 4) 根据一定的搜索策略从待抓取 URL 队列中选择下一步要抓取的网页 URL.重复以上步骤,直至满足退出条件时停止[2].

1. 2 聚焦爬虫的几个关键技术

根据聚焦爬虫的工作原理,在设计聚焦爬虫时,需要考虑问题可做如下阐述。

1. 2. 1 待抓取网站目标的定义与描述的问题

开发聚焦爬虫时,应考虑对于抓取目标的定义与描述,究竟是带有目标网页特点的网页级信息,还是针对目标网页上的结构化数据。前者因其具有结构化的数据信息特点,在爬虫抓取信息后,还需从结构化的网页中抽取相关信息; 而对于前者,爬虫则直接解析 Web 页面,提取并加工相关的结构化数据信息,该类爬虫以便订制自适应于特定网页模板的结果网站。

1. 2. 2 爬虫的 URL 搜索策略问题

开发聚焦爬虫时,常见的 URL 搜索策略主要包括深度优先搜索策略、广度优先搜索策略、最佳优先搜索策略等[3].在此给出对应策略的规则剖析如下。

( 1) 深度优先搜索策略

该搜索策略采用了后进先出的队列形式,从起始 URL出发,不停搜索网页的下一级页面直到最后无 URL 链接的网页页面结束; 爬虫再回到起始 URL 地址,继续追寻 URL的其它 URL 链接,直到不再有 URL 可搜索为止,当所有页面都结束时,URL 列表即根据插叙的方法将搜索的 URL 队列送入爬虫待抓取队列。

( 2) 广度优先搜索策略

该搜索策略采用了先进先出的队列形式,从起始 URL出发,在搜索了初始 Web 的所有 URL 链接后,再继续搜索下一层 URL 链接,直至所有 URL 搜索完毕。URL 列表将依照其步入队列的次序送入爬虫待抓取队列。

( 3) 最佳优先搜索策略

该搜索策略采用了一种局部优先搜索算法,从起始 URL出发,按照一定的剖析算法,对页面候选的 URL 进行预测,预测目标网页的相似度或主题相关性,当相关性达到一定的阀值后,URL 列表则根据相关数值高低次序送入爬虫待抓取队列。

1. 2. 3 爬虫对网页页面的剖析和主题相关性判定算法

聚焦爬虫在对网页 Web 的 URL 进行扩充时,还须要对网页内容进行剖析和信息的提取开源网络爬虫,用以确定该获取 URL 页面是否与采集的主题相关。目前常用的网页的剖析算法包括: 基于网路拓扑、基于网页内容和基于领域概念的剖析算法[4].下面给出这三类算法的原理实现。

( 1) 基于网路拓扑关系的剖析算法

基于网路拓扑关系的剖析算法就是可以通过已知的网页页面或数据,对与其有直接或间接链接关系的对象做出评价的实现过程。该算法又分为网页细度、网站粒度和网页块细度三种。着名的 PageRank 和 HITS 算法就是基于网路拓扑关系的典型代表。

( 2) 基于网页内容的剖析算法

基于网页内容的剖析算法指的是借助网页内容( 文本、数据等资源) 特征进行的网页评价。该方式已从最初的文本检索方式,向网页数据抽取、数据挖掘和自然语言等多领域方向发展。

( 3) 基于领域概念的剖析算法

基于领域概念的剖析算法则是将领域本体分解为由不同的概念、实体及其之间的关系,包括与之对应的词汇项组成。网页中的关键词在通过与领域本体对应的辞典分别转换以后,将进行计数和加权,由此得出与所选领域的相关度。

用python写网路爬虫电子书下载 pdf完整扫描版[百度网盘资源]

采集交流 • 优采云 发表了文章 • 0 个评论 • 314 次浏览 • 2020-06-05 08:01

内容介绍

《用python写网络爬虫》讲解了怎样使用Python来编撰网路爬虫程序,内容包括网路爬虫简介,从页面中抓取数据的三种方式,提取缓存中的数据,使用多个线程和进程来进行并发抓取,如何抓取动态页面中的内容,与表单进行交互,处理页面中的验证码问题,以及使用Scarpy和Portia来进行数据抓取,使用本书介绍的数据抓取技术对几个真实的网站进行了抓取,旨在帮助读者活学活用书中介绍的技术,能够适宜有一定Python编程经验,而且对爬虫技术感兴趣的读者阅读。

用python写网路爬虫章节目录

第1章 网络爬虫简介 1

1.1 网络爬虫何时有用 1

1.2 网络爬虫是否合法 2

1.3 背景调研 3

1.3.1 检查robots.txt 3

1.3.2 检查网站地图 4

1.3.3 估算网站大小 5

1.3.4 识别网站所用技术 7

1.3.5 寻找网站所有者 7

1.4 编写第一个网络爬虫 8

1.4.1 下载网页 9

1.4.2 网站地图爬虫 12

1.4.3 ID遍历爬虫 13

1.4.4 链接爬虫 15

1.5 本章小结 22

第2章 数据抓取 23

2.1 分析网页 23

2.2 三种网页抓取方法 26

2.2.1 正则表达式 26

2.2.2 Beautiful Soup 28

2.2.3 Lxml 30

2.2.4 性能对比 32

2.2.5 结论 35

2.2.6 为链接爬虫添加抓取回调 35

2.3 本章小结 38

第3章 下载缓存 39

3.1 为链接爬虫添加缓存支持 39

3.2 磁盘缓存 42

3.2.1 实现 44

3.2.2 缓存测试 46

3.2.3 节省磁盘空间 46

3.2.4 清理过期数据 47

3.2.5 缺点 48

3.3 数据库缓存 49

3.3.1 NoSQL是什么 50

3.3.2 安装MongoDB 50

3.3.3 MongoDB概述 50

3.3.4 MongoDB缓存实现 52

3.3.5 压缩 54

3.3.6 缓存测试 54

3.4 本章小结 55

第4章 并发下载 57

4.1 100万个网页 57

4.2 串行爬虫 60

4.3 多线程爬虫 60

4.3.1 线程和进程如何工作 61

4.3.2 实现 61

4.3.3 多进程爬虫 63

4.4 性能 67

4.5 本章小结 68

第5章 动态内容 69

5.1 动态网页示例 69

5.2 对动态网页进行逆向工程 72

5.3 渲染动态网页 77

5.3.1 PyQt还是PySide 78

5.3.2 执行JavaScript 78

5.3.3 使用WebKit与网站交互 80

5.3.4 Selenium 85

5.4 本章小结 88

第6章 表单交互 89

6.1 登录表单 90

6.2 支持内容更新的登录脚本扩展 97

6.3 使用Mechanize模块实现自动化表单处理 100

6.4 本章小结 102

第7章 验证码处理 103

7.1 注册账号 103

7.2 光学字符识别 106

7.3 处理复杂验证码 111

7.3.1 使用验证码处理服务 112

7.3.2 9kw入门 112

7.3.3 与注册功能集成 119

7.4 本章小结 120

第8章 Scrapy 121

8.1 安装 121

8.2 启动项目 122

8.2.1 定义模型 123

8.2.2 创建爬虫 124

8.2.3 使用shell命令抓取 128

8.2.4 检查结果 129

8.2.5 中断与恢复爬虫 132

8.3 使用Portia编写可视化爬虫 133

8.3.1 安装 133

8.3.2 标注 136

8.3.3 优化爬虫 138

8.3.4 检查结果 140

8.4 使用Scrapely实现自动化抓取 141

8.5 本章小结 142

第9章 总结 143

9.1 Google搜索引擎 143

9.2 Facebook 148

9.2.1 网站 148

9.2.2 API 150

9.3 Gap 151

9.4 宝马 153

9.5 本章小结 157

使用说明

1、下载并解压,得出pdf文件

2、如果打不开本文件python网络爬虫 pdf,请勿必下载pdf阅读器

3、安装后,在打开解压得出的pdf文件

4、双击进行阅读 查看全部

用python写网路爬虫是一本用Python进行数据处理和数据挖掘的代表专著,由美国程序员理查德·劳森(Richard Lawson)编著。本书讲解了从静态页面爬取数据的方式以及使用缓存来管理服务器负载的方式。此外,还介绍了怎样使用AJAX URL和Firebug扩充来爬取数据,以及有关爬取技术的更多真相,比如使用浏览器渲染、管理cookie、通过递交表单从受验证码保护的复杂网站中抽取数据等,能够帮助python人员更好的学习常攥好python编程。用python写网路爬虫主要内容包括通过跟踪链接来爬取网站;使用lxml从页面中抽取数据;构建线程爬虫来并行爬取页面;解析依赖于JavaScript的网站;与表单和会话进行交互;解决受保护页面的验证码问题等等python网络爬虫 pdf,欢迎免费下载阅读。

内容介绍

《用python写网络爬虫》讲解了怎样使用Python来编撰网路爬虫程序,内容包括网路爬虫简介,从页面中抓取数据的三种方式,提取缓存中的数据,使用多个线程和进程来进行并发抓取,如何抓取动态页面中的内容,与表单进行交互,处理页面中的验证码问题,以及使用Scarpy和Portia来进行数据抓取,使用本书介绍的数据抓取技术对几个真实的网站进行了抓取,旨在帮助读者活学活用书中介绍的技术,能够适宜有一定Python编程经验,而且对爬虫技术感兴趣的读者阅读。

用python写网路爬虫章节目录

第1章 网络爬虫简介 1

1.1 网络爬虫何时有用 1

1.2 网络爬虫是否合法 2

1.3 背景调研 3

1.3.1 检查robots.txt 3

1.3.2 检查网站地图 4

1.3.3 估算网站大小 5

1.3.4 识别网站所用技术 7

1.3.5 寻找网站所有者 7

1.4 编写第一个网络爬虫 8

1.4.1 下载网页 9

1.4.2 网站地图爬虫 12

1.4.3 ID遍历爬虫 13

1.4.4 链接爬虫 15

1.5 本章小结 22

第2章 数据抓取 23

2.1 分析网页 23

2.2 三种网页抓取方法 26

2.2.1 正则表达式 26

2.2.2 Beautiful Soup 28

2.2.3 Lxml 30

2.2.4 性能对比 32

2.2.5 结论 35

2.2.6 为链接爬虫添加抓取回调 35

2.3 本章小结 38

第3章 下载缓存 39

3.1 为链接爬虫添加缓存支持 39

3.2 磁盘缓存 42

3.2.1 实现 44

3.2.2 缓存测试 46

3.2.3 节省磁盘空间 46

3.2.4 清理过期数据 47

3.2.5 缺点 48

3.3 数据库缓存 49

3.3.1 NoSQL是什么 50

3.3.2 安装MongoDB 50

3.3.3 MongoDB概述 50

3.3.4 MongoDB缓存实现 52

3.3.5 压缩 54

3.3.6 缓存测试 54

3.4 本章小结 55

第4章 并发下载 57

4.1 100万个网页 57

4.2 串行爬虫 60

4.3 多线程爬虫 60

4.3.1 线程和进程如何工作 61

4.3.2 实现 61

4.3.3 多进程爬虫 63

4.4 性能 67

4.5 本章小结 68

第5章 动态内容 69

5.1 动态网页示例 69

5.2 对动态网页进行逆向工程 72

5.3 渲染动态网页 77

5.3.1 PyQt还是PySide 78

5.3.2 执行JavaScript 78

5.3.3 使用WebKit与网站交互 80

5.3.4 Selenium 85

5.4 本章小结 88

第6章 表单交互 89

6.1 登录表单 90

6.2 支持内容更新的登录脚本扩展 97

6.3 使用Mechanize模块实现自动化表单处理 100

6.4 本章小结 102

第7章 验证码处理 103

7.1 注册账号 103

7.2 光学字符识别 106

7.3 处理复杂验证码 111

7.3.1 使用验证码处理服务 112

7.3.2 9kw入门 112

7.3.3 与注册功能集成 119

7.4 本章小结 120

第8章 Scrapy 121

8.1 安装 121

8.2 启动项目 122

8.2.1 定义模型 123

8.2.2 创建爬虫 124

8.2.3 使用shell命令抓取 128

8.2.4 检查结果 129

8.2.5 中断与恢复爬虫 132

8.3 使用Portia编写可视化爬虫 133

8.3.1 安装 133

8.3.2 标注 136

8.3.3 优化爬虫 138

8.3.4 检查结果 140

8.4 使用Scrapely实现自动化抓取 141

8.5 本章小结 142

第9章 总结 143

9.1 Google搜索引擎 143

9.2 Facebook 148

9.2.1 网站 148

9.2.2 API 150

9.3 Gap 151

9.4 宝马 153

9.5 本章小结 157

使用说明

1、下载并解压,得出pdf文件

2、如果打不开本文件python网络爬虫 pdf,请勿必下载pdf阅读器

3、安装后,在打开解压得出的pdf文件

4、双击进行阅读

网络爬虫 | 开源软件 | OSCHINA

采集交流 • 优采云 发表了文章 • 0 个评论 • 365 次浏览 • 2020-06-04 08:05

SimpleCD是哪些? 是山寨化VeryCD的全套工具,包括抓取脚本,网站代码等 谁须要使用SimpleCD? 想保存VeryCD链接资源者:别镜像VeryCD了,用这个吧。 想研究爬虫脚本和...

Nutch 是一个开源Java 实现的搜索引擎。它提供了我们运行自己的搜索引擎所需的全部工具。包括全文搜索和Web爬虫。 Nutch的创始人是Doug Cutting,他同时也是Lucene、H...

收藏 962

更新于 2019/10/18

webmagic的是一个无须配置、便于二次开发的爬虫框架,它提供简单灵活的API,只需少量代码即可实现一个爬虫。 以下是爬取oschina博客的一段代码: Spider.create(newS...

收藏 1071

更新于 2017/07/31

Scrapy 是一套基于基于Twisted的异步处理框架,纯python实现的爬虫框架,用户只须要订制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内容以及各类图片,非常之便捷~ 示例代码:...

收藏 482

更新于 2020/03/05

Soukey采摘网站数据采集软件是一款基于.Net平台的开源软件,也是网站数据采集软件类型中惟一一款开源软件。尽管Soukey采摘开源,但并不会影响软件功能的提供网络爬虫软件,甚至要比一些商用软件的功能还要...

PySipder 是一个 Python 爬虫程序 演示地址: 使用 Python 编写脚本,提供强悍的 API Python 2&3 强大的 W...

PhpDig是一个采用PHP开发的Web爬虫和搜索引擎。通过对动态和静态页面进行索引构建一个词汇表。当搜索查询时,它将按一定的排序规则显示包含关 键字的搜索结果页面。PhpDig包含一个模板系统...

Heritrix是一个开源,可扩充的web爬虫项目。用户可以使用它来从网上抓取想要的资源。Heritrix设计成严格依照robots.txt文件的排除指示和META robots标签。其最出色之...

Grub Next Generation 是一个分布式的网页爬虫系统,包含客户端和服务器可以拿来维护网页的索引。

收藏 117

更新于 2011/05/26

Snoopy是一个强悍的网站内容采集器(爬虫)。提供获取网页内容,提交表单等功能。

已删掉源码

收藏 881

更新于 2016/09/26

Spiderman - 又一个Java网路蜘蛛/爬虫 Spiderman 是一个基于微内核+插件式构架的网路蜘蛛,它的目标是通过简单的方式能够将复杂的目标网页信息抓取并解析为自己所须要的业务数据...

NWebCrawler是一款开源的C#网路爬虫程序

JSpider是一个用Java实现的WebSpider,JSpider的执行格式如下: jspider [URL] [ConfigName] URL一定要加上合同名称,如:网络爬虫软件,否则会...

开源软件作者

RedisPlus 作者

ACTCMS 作者

静静的风

DBErp 作者

Crawler4j是一个开源的Java泛型提供一个用于抓取Web页面的简单插口。可以借助它来建立一个多线程的Web爬虫。 示例代码: import java.util.ArrayList; im...

收藏 116

更新于 2017/11/28

爬虫软件MetaSeeker,现已全面升级为GooSeeker。 新版本早已发布,在线版免费下载和使用,源代码可阅读。自推出以来,深受喜爱,主要应用领域: 垂直搜索(Vertical Searc...

OpenWebSpider是一个开源多线程Web Spider(robot:机器人,crawler:爬虫)和包含许多有趣功能的搜索引擎。

国内第一个针对微博数据的爬虫程序!原名“新浪微博爬虫”。 登录后,可以指定用户为起点,以该用户的关注人、粉丝为线索,延人脉关系收集用户基本信息、微博数据、评论数据。 该应用获取的数据可作为科研、...

Methanol 是一个模块化的可订制的网页爬虫软件,主要的优点是速度快。

没有更多内容

加载失败,请刷新页面

加载更多 查看全部

爬虫简介: WebCollector 是一个无须配置、便于二次开发的 Java 爬虫框架(内核),它提供精简的的 API,只需少量代码即可实现一个功能强悍的爬虫。WebCollector-Had...

SimpleCD是哪些? 是山寨化VeryCD的全套工具,包括抓取脚本,网站代码等 谁须要使用SimpleCD? 想保存VeryCD链接资源者:别镜像VeryCD了,用这个吧。 想研究爬虫脚本和...

Nutch 是一个开源Java 实现的搜索引擎。它提供了我们运行自己的搜索引擎所需的全部工具。包括全文搜索和Web爬虫。 Nutch的创始人是Doug Cutting,他同时也是Lucene、H...

收藏 962

更新于 2019/10/18

webmagic的是一个无须配置、便于二次开发的爬虫框架,它提供简单灵活的API,只需少量代码即可实现一个爬虫。 以下是爬取oschina博客的一段代码: Spider.create(newS...

收藏 1071

更新于 2017/07/31

Scrapy 是一套基于基于Twisted的异步处理框架,纯python实现的爬虫框架,用户只须要订制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内容以及各类图片,非常之便捷~ 示例代码:...

收藏 482

更新于 2020/03/05

Soukey采摘网站数据采集软件是一款基于.Net平台的开源软件,也是网站数据采集软件类型中惟一一款开源软件。尽管Soukey采摘开源,但并不会影响软件功能的提供网络爬虫软件,甚至要比一些商用软件的功能还要...

PySipder 是一个 Python 爬虫程序 演示地址: 使用 Python 编写脚本,提供强悍的 API Python 2&3 强大的 W...

PhpDig是一个采用PHP开发的Web爬虫和搜索引擎。通过对动态和静态页面进行索引构建一个词汇表。当搜索查询时,它将按一定的排序规则显示包含关 键字的搜索结果页面。PhpDig包含一个模板系统...

Heritrix是一个开源,可扩充的web爬虫项目。用户可以使用它来从网上抓取想要的资源。Heritrix设计成严格依照robots.txt文件的排除指示和META robots标签。其最出色之...

Grub Next Generation 是一个分布式的网页爬虫系统,包含客户端和服务器可以拿来维护网页的索引。

收藏 117

更新于 2011/05/26

Snoopy是一个强悍的网站内容采集器(爬虫)。提供获取网页内容,提交表单等功能。

已删掉源码

收藏 881

更新于 2016/09/26

Spiderman - 又一个Java网路蜘蛛/爬虫 Spiderman 是一个基于微内核+插件式构架的网路蜘蛛,它的目标是通过简单的方式能够将复杂的目标网页信息抓取并解析为自己所须要的业务数据...

NWebCrawler是一款开源的C#网路爬虫程序

JSpider是一个用Java实现的WebSpider,JSpider的执行格式如下: jspider [URL] [ConfigName] URL一定要加上合同名称,如:网络爬虫软件,否则会...

开源软件作者

RedisPlus 作者

ACTCMS 作者

静静的风

DBErp 作者

Crawler4j是一个开源的Java泛型提供一个用于抓取Web页面的简单插口。可以借助它来建立一个多线程的Web爬虫。 示例代码: import java.util.ArrayList; im...

收藏 116

更新于 2017/11/28

爬虫软件MetaSeeker,现已全面升级为GooSeeker。 新版本早已发布,在线版免费下载和使用,源代码可阅读。自推出以来,深受喜爱,主要应用领域: 垂直搜索(Vertical Searc...

OpenWebSpider是一个开源多线程Web Spider(robot:机器人,crawler:爬虫)和包含许多有趣功能的搜索引擎。

国内第一个针对微博数据的爬虫程序!原名“新浪微博爬虫”。 登录后,可以指定用户为起点,以该用户的关注人、粉丝为线索,延人脉关系收集用户基本信息、微博数据、评论数据。 该应用获取的数据可作为科研、...

Methanol 是一个模块化的可订制的网页爬虫软件,主要的优点是速度快。

没有更多内容

加载失败,请刷新页面

加载更多

什么是网络爬虫?网络爬虫有哪些用?

采集交流 • 优采云 发表了文章 • 0 个评论 • 296 次浏览 • 2020-06-01 08:01

什么是爬虫?

网络蜘蛛(Web spider)也叫网络爬虫(Web crawler)什么是网络爬虫,蚂蚁(ant),自动检索工具(automatic indexer),或者(在FOAF软件概念中)网络疾走(WEB scutter),是一种“自动化浏览网路”的程序,或者说是一种网路机器人。它们被广泛用于互联网搜索引擎或其他类似网站,以获取或更新那些网站的内容和检索方法。它们可以手动采集所有其才能访问到的页面内容,以供搜索引擎做进一步处理(分检整理下载的页面),而促使用户能更快的检索到她们须要的信息。

最常见的就是互联网搜索引擎,它们借助网路爬虫手动采集所有才能访问到的页面内容,以获取或更新那些网站的内容和检索方法。在网路爬虫的系统框架中,主过程由控制器、解析器、资源库三部份组成。控制器的主要工作是负责给多线程中的各个爬虫线程分配工作任务。解析器的主要工作是

下载信息,将信息中对用户没有意义的内容(比如网页代码)处理掉。资源库是拿来储存下载到的数据资源,并对其构建索引。

假如你想要每小时抓取一次网易新闻,那么你就要访问网易并做一个数据恳求,得到html格式的网页,然后通过网路爬虫的解析器进行过滤,最后保存入库。

爬虫能做哪些?

可以创建搜索引擎(Google,百度)

可以拿来抢火车票

带逛

简单来讲只要浏览器能打开的,都可以用爬虫实现

网络爬虫的分类?

网络爬虫可以分为通用网路爬虫(General Purpose Web Crawler)、聚焦网络爬虫(Focused Web Crawler)、增量式网络爬虫(Incremental Web Crawler)和深层网络爬虫(Deep Web Crawler)。通用网路爬虫又称全网爬虫(Scalable Web Crawler),爬行对象从一些种子 URL(网络上每一个文件都有一个地址,即URL) 扩充到整个 Web,主要为门户站点搜索引擎和小型 Web 服务提供商采集数据。 由于商业缘由,它们的技术细节甚少公布下来。

聚焦网络爬虫(Focused Crawler),又称主题网路爬虫(Topical Crawler),是只爬行与主题相关网路资源的爬虫。它极大地节约了硬件和网路资源,保存的数据也因为数目少而更新快,还可以挺好地满足一些特定人群对特定领域信息的需求。

增量式网络爬虫(Incremental Web Crawler)是指只爬行新形成的或则已然发生变化数据的爬虫,它还能在一定程度上保证所爬行的数据是尽可能新的,并不重新下载没有发生变化的数据,可有效降低数据下载量,及时更新已爬行的数据,减小时间和空间上的花费。

深层网络爬虫(Deep Web Crawler)则可以抓取到深层网页的数据。一般网路页面分为表层网页和深层网页。 表层网页是指传统搜索引擎可以索引的页面什么是网络爬虫,而深层页面是只有用户递交一些关键词能够获得的页面,例如这些用户注册后内容才可见的网页就属于深层网页。

学习爬虫技术势在必行:在现今竞争的信息化社会中,如何借助数据剖析使自己站在信息不对称的一方,保持竞争优势,是数字工作者的必备技能。不过想飞之前总得先学会慢跑,分析数据之前先首要学会爬数据与处理数据,才有有事半功倍之效。

【全文完】 查看全部

在大数据浪潮中,最值钱的就是数据,企业为了获得数据,处理数据,理解数据耗费了巨大代价,使用网络爬虫可以最有效的获取数据。

什么是爬虫?

网络蜘蛛(Web spider)也叫网络爬虫(Web crawler)什么是网络爬虫,蚂蚁(ant),自动检索工具(automatic indexer),或者(在FOAF软件概念中)网络疾走(WEB scutter),是一种“自动化浏览网路”的程序,或者说是一种网路机器人。它们被广泛用于互联网搜索引擎或其他类似网站,以获取或更新那些网站的内容和检索方法。它们可以手动采集所有其才能访问到的页面内容,以供搜索引擎做进一步处理(分检整理下载的页面),而促使用户能更快的检索到她们须要的信息。

最常见的就是互联网搜索引擎,它们借助网路爬虫手动采集所有才能访问到的页面内容,以获取或更新那些网站的内容和检索方法。在网路爬虫的系统框架中,主过程由控制器、解析器、资源库三部份组成。控制器的主要工作是负责给多线程中的各个爬虫线程分配工作任务。解析器的主要工作是

下载信息,将信息中对用户没有意义的内容(比如网页代码)处理掉。资源库是拿来储存下载到的数据资源,并对其构建索引。

假如你想要每小时抓取一次网易新闻,那么你就要访问网易并做一个数据恳求,得到html格式的网页,然后通过网路爬虫的解析器进行过滤,最后保存入库。

爬虫能做哪些?

可以创建搜索引擎(Google,百度)

可以拿来抢火车票

带逛

简单来讲只要浏览器能打开的,都可以用爬虫实现

网络爬虫的分类?

网络爬虫可以分为通用网路爬虫(General Purpose Web Crawler)、聚焦网络爬虫(Focused Web Crawler)、增量式网络爬虫(Incremental Web Crawler)和深层网络爬虫(Deep Web Crawler)。通用网路爬虫又称全网爬虫(Scalable Web Crawler),爬行对象从一些种子 URL(网络上每一个文件都有一个地址,即URL) 扩充到整个 Web,主要为门户站点搜索引擎和小型 Web 服务提供商采集数据。 由于商业缘由,它们的技术细节甚少公布下来。

聚焦网络爬虫(Focused Crawler),又称主题网路爬虫(Topical Crawler),是只爬行与主题相关网路资源的爬虫。它极大地节约了硬件和网路资源,保存的数据也因为数目少而更新快,还可以挺好地满足一些特定人群对特定领域信息的需求。

增量式网络爬虫(Incremental Web Crawler)是指只爬行新形成的或则已然发生变化数据的爬虫,它还能在一定程度上保证所爬行的数据是尽可能新的,并不重新下载没有发生变化的数据,可有效降低数据下载量,及时更新已爬行的数据,减小时间和空间上的花费。

深层网络爬虫(Deep Web Crawler)则可以抓取到深层网页的数据。一般网路页面分为表层网页和深层网页。 表层网页是指传统搜索引擎可以索引的页面什么是网络爬虫,而深层页面是只有用户递交一些关键词能够获得的页面,例如这些用户注册后内容才可见的网页就属于深层网页。

学习爬虫技术势在必行:在现今竞争的信息化社会中,如何借助数据剖析使自己站在信息不对称的一方,保持竞争优势,是数字工作者的必备技能。不过想飞之前总得先学会慢跑,分析数据之前先首要学会爬数据与处理数据,才有有事半功倍之效。

【全文完】

集搜客网络爬虫(网页内容抓取软件)V8.2.2 最新版软件下载

采集交流 • 优采云 发表了文章 • 0 个评论 • 311 次浏览 • 2020-06-01 08:00

集搜客网络爬虫(网页内容抓取软件)是一款强悍好用的网站内容采集软件。集搜客网络爬虫操作上去十分的简便快捷,能够按照指定的规则手动抓取网页中的各类内容并发布到自己网站上,简单易用,不需要技术基础,只需点击滑鼠才能采集数据,是个人站长采集网站内容的必备工具。根据指定的规则手动抓取网页中的各类内容并发布到自己网站上,需要的同学欢迎来下载。

1、可视化免编程

全图形化操作界面,可视化操作,无需编程基础,熟悉电脑操作即可轻松把握,只需在网页上点点键盘操作,即可生成抓取规则 ,抓取结果即时验证

2、模板资源套用

资源库有大量的抓取模板,均经过官方验证,可直接套用,一键抓取即可获得您想要的数据

3、通用网路爬虫

支持所有语言抓取,地域没有限制,网站类型没有限制,动态静态网页采集方法完全一样,资源库提供海外网站的抓取模板

4、会员互助抓取

当须要大批量频繁采集时,在社区以悬赏的形式发布采集任务,接受了任务的会员还会用自己笔记本为您分担采集任务,实现异地并行抓取

5、不限深度和广度

针对小型网站,通过抓取网页中的超链接,爬虫可以深入到所有层级页面抓取所需数据,并转化为结构化的信息

6、抓指数抓图表

爬虫软件除了能抓取文本数据、图片、表格,还能模拟滑鼠联通并抓取在指数图表上漂浮显示的数据,让整个互联网成为您的数据资源库

7、本地化储存保护隐私

软件在本地笔记本上运行,抓取结果文件也储存在本地笔记本中,方便您的数据保护和备份,隐私安全有保障

8、自动登入验证码识别

软件具有手动登入功能,可以手动登入账号、自动辨识并输入验证码,有效避免数据抓取中断,无需人工看管

9、定时自启动采集

软件可以设置周期性手动采集,实现持续的增量数据采集,有利于舆情监控、商品比价和大数据挖掘

10、爬虫群并行抓取

当面临大批量采集任务时,可以在同一台笔记本启动多个爬虫网络爬虫软件下载,同时采集一个或多个网站的数据;还可以把爬虫分布到不同地点的不同笔记本上同时抓取,提高抓取效率

11、启动"集搜"多爬虫抓数据

"集搜"功能才能支持同一台笔记本手工启动并行运行多个爬虫窗口,无需编程网络爬虫软件下载,只需在DS打数机的操作界面的抓取规则列表上点击"集搜"按钮,就能为该规则启动一个爬虫窗口。

12、手机网站数据抓取

爬虫除了可以抓取PC网站上的数据,还可以抓取手机网站上的数据,全面掌握PC端和移动端最新消息资讯。 查看全部

集搜客网络爬虫(网页内容抓取软件)是一款强悍好用的网站内容采集软件。集搜客网络爬虫操作上去十分的简便快捷,能够按照指定的规则手动抓取网页中的各类内容并发布到自己网站上,简单易用,不需要技术基础,只需点击滑鼠才能采集数据,是个人站长采集网站内容的必备工具。根据指定的规则手动抓取网页中的各类内容并发布到自己网站上,需要的同学欢迎来下载。

1、可视化免编程

全图形化操作界面,可视化操作,无需编程基础,熟悉电脑操作即可轻松把握,只需在网页上点点键盘操作,即可生成抓取规则 ,抓取结果即时验证

2、模板资源套用

资源库有大量的抓取模板,均经过官方验证,可直接套用,一键抓取即可获得您想要的数据

3、通用网路爬虫

支持所有语言抓取,地域没有限制,网站类型没有限制,动态静态网页采集方法完全一样,资源库提供海外网站的抓取模板

4、会员互助抓取

当须要大批量频繁采集时,在社区以悬赏的形式发布采集任务,接受了任务的会员还会用自己笔记本为您分担采集任务,实现异地并行抓取

5、不限深度和广度

针对小型网站,通过抓取网页中的超链接,爬虫可以深入到所有层级页面抓取所需数据,并转化为结构化的信息

6、抓指数抓图表

爬虫软件除了能抓取文本数据、图片、表格,还能模拟滑鼠联通并抓取在指数图表上漂浮显示的数据,让整个互联网成为您的数据资源库

7、本地化储存保护隐私

软件在本地笔记本上运行,抓取结果文件也储存在本地笔记本中,方便您的数据保护和备份,隐私安全有保障

8、自动登入验证码识别

软件具有手动登入功能,可以手动登入账号、自动辨识并输入验证码,有效避免数据抓取中断,无需人工看管

9、定时自启动采集

软件可以设置周期性手动采集,实现持续的增量数据采集,有利于舆情监控、商品比价和大数据挖掘

10、爬虫群并行抓取

当面临大批量采集任务时,可以在同一台笔记本启动多个爬虫网络爬虫软件下载,同时采集一个或多个网站的数据;还可以把爬虫分布到不同地点的不同笔记本上同时抓取,提高抓取效率

11、启动"集搜"多爬虫抓数据

"集搜"功能才能支持同一台笔记本手工启动并行运行多个爬虫窗口,无需编程网络爬虫软件下载,只需在DS打数机的操作界面的抓取规则列表上点击"集搜"按钮,就能为该规则启动一个爬虫窗口。

12、手机网站数据抓取

爬虫除了可以抓取PC网站上的数据,还可以抓取手机网站上的数据,全面掌握PC端和移动端最新消息资讯。

网络爬虫简介(5)— 链接爬虫

采集交流 • 优采云 发表了文章 • 0 个评论 • 370 次浏览 • 2020-05-31 08:01

到目前为止,我们早已借助示例网站的结构特性实现了两个简单爬虫,用于下载所有已发布的国家(或地区)页面。只要这两种技术可用,就应该使用它们进行爬取,因为这两种方式将须要下载的网页数目降至最低。不过,对于另一些网站爬虫社区,我们须要使爬虫表现得更象普通用户,跟踪链接,访问感兴趣的内容。

通过跟踪每位链接的方法,我们可以很容易地下载整个网站的页面。但是,这种方式可能会下载好多并不需要的网页。例如,我们想要从一个在线峰会中抓取用户帐号详情页,那么此时我们只须要下载帐号页,而不需要下载讨论贴的页面。本章使用的链接爬虫将使用正则表达式来确定应该下载什么页面。下面是这段代码的初始版本。

import re

def link_crawler(start_url, link_regex):

""" Crawl from the given start URL following links matched by

link_regex

"""

crawl_queue = [start_url]

while crawl_queue:

url = crawl_queue.pop()

html = download(url)

if html is not None:

continue

# filter for links matching our regular expression

for link in get_links(html):

if re.match(link_regex, link):

crawl_queue.append(link)

def get_links(html):

""" Return a list of links from html

"""

# a regular expression to extract all links from the webpage

webpage_regex = re.compile("""<a[^>]+href=["'](.*?)["']""",

re.IGNORECASE)

# list of all links from the webpage

return webpage_regex.findall(html)

要运行这段代码,只须要调用

link_crawler

函数,并传入两个参数:

要爬取的网站

URL

以及用于匹配你想跟踪的链

接的正则表达式。对于示例网

站来说,我们想要爬取的是国家(或地区

)列表索引页和国家(或地区)页面。

我们查看站点可以获知索引页链接遵守如下格式:

国家(或地区)页遵守如下格式:

因此爬虫社区,我们可以用/(index|view)/这个简单的正则表达式来匹配这两类网页。当爬虫使用这种输入参数运行时会发生哪些呢?你会得到如下所示的下载错误。

>>> link_crawler('http://example.python-scraping.com', '/(index|view)/')

Downloading: http://example.python-scraping.com

Downloading: /index/1

Traceback (most recent call last):

...

ValueError: unknown url type: /index/1

正则表达式是从字符串中抽取信息的非常好的工具,因此我推荐每名程序员都应该“学会怎样阅读和编撰一些正则表达式”。即便这么,它们常常会特别脆弱,容易失效。我们将在本书后续部份介绍更先进的抽取链接和辨识页面的形式。可以看出,问题出在下载/index/1时,该链接只有网页的路径部份,而没有合同和服务器部份,也就是说这是一个相对链接。由于浏览器晓得你正在浏览那个网页,并且还能采取必要步骤处理那些链接,因此在浏览器浏览时,相对链接是才能正常工作的。但是,urllib并没有上下文。为了使urllib才能定位网页,我们须要将链接转换为绝对链接的方式,以便包含定位网页的所有细节。如你所愿,Python的urllib中有一个模块可以拿来实现该功能,该模块名为parse。下面是link_crawler的改进版本,使用了urljoin方式来创建绝对路径。

from urllib.parse import urljoin

def link_crawler(start_url, link_regex):

""" Crawl from the given start URL following links matched by

link_regex

"""

crawl_queue = [start_url]

while crawl_queue:

url = crawl_queue.pop()

html = download(url)

if not html:

continue

for link in get_links(html):

if re.match(link_regex, link):

abs_link = urljoin(start_url, link)

crawl_queue.append(abs_link)

当你运行这段代码时,会听到似乎下载了匹配的网页,但是同样的地点总是会被不断下载到。产生该行为的诱因是那些地点互相之间存在链接。比如,澳大利亚链接到了南极洲,而南极洲又链接回了德国,此时爬虫都会继续将这种URL装入队列,永远不会抵达队列尾部

。要想避开重复爬取相同的链接,我们须要记录什么链接早已被爬取过。下面是更改后的link_crawler函数,具备了储存已发觉URL的功能,可以避免重复下载。

def link_crawler(start_url, link_regex):

crawl_queue = [start_url]

# keep track which URL's have seen before

seen = set(crawl_queue)

while crawl_queue:

url = crawl_queue.pop()

html = download(url)

if not html:

continue

for link in get_links(html):

# check if link matches expected regex

if re.match(link_regex, link):

abs_link = urljoin(start_url, link)

# check if have already seen this link

if abs_link not in seen:

seen.add(abs_link)

crawl_queue.append(abs_link)

当运行该脚本时,它会爬取所有地点,并且还能如期停止。最终,我们得到了一个可用的链接爬虫! 查看全部

1.5.5 链接爬虫

到目前为止,我们早已借助示例网站的结构特性实现了两个简单爬虫,用于下载所有已发布的国家(或地区)页面。只要这两种技术可用,就应该使用它们进行爬取,因为这两种方式将须要下载的网页数目降至最低。不过,对于另一些网站爬虫社区,我们须要使爬虫表现得更象普通用户,跟踪链接,访问感兴趣的内容。

通过跟踪每位链接的方法,我们可以很容易地下载整个网站的页面。但是,这种方式可能会下载好多并不需要的网页。例如,我们想要从一个在线峰会中抓取用户帐号详情页,那么此时我们只须要下载帐号页,而不需要下载讨论贴的页面。本章使用的链接爬虫将使用正则表达式来确定应该下载什么页面。下面是这段代码的初始版本。

import re

def link_crawler(start_url, link_regex):

""" Crawl from the given start URL following links matched by

link_regex

"""

crawl_queue = [start_url]

while crawl_queue:

url = crawl_queue.pop()

html = download(url)

if html is not None:

continue

# filter for links matching our regular expression

for link in get_links(html):

if re.match(link_regex, link):

crawl_queue.append(link)

def get_links(html):

""" Return a list of links from html

"""

# a regular expression to extract all links from the webpage

webpage_regex = re.compile("""<a[^>]+href=["'](.*?)["']""",

re.IGNORECASE)

# list of all links from the webpage

return webpage_regex.findall(html)

要运行这段代码,只须要调用

link_crawler

函数,并传入两个参数:

要爬取的网站

URL

以及用于匹配你想跟踪的链

接的正则表达式。对于示例网

站来说,我们想要爬取的是国家(或地区

)列表索引页和国家(或地区)页面。

我们查看站点可以获知索引页链接遵守如下格式:

国家(或地区)页遵守如下格式:

因此爬虫社区,我们可以用/(index|view)/这个简单的正则表达式来匹配这两类网页。当爬虫使用这种输入参数运行时会发生哪些呢?你会得到如下所示的下载错误。

>>> link_crawler('http://example.python-scraping.com', '/(index|view)/')

Downloading: http://example.python-scraping.com

Downloading: /index/1

Traceback (most recent call last):

...

ValueError: unknown url type: /index/1

正则表达式是从字符串中抽取信息的非常好的工具,因此我推荐每名程序员都应该“学会怎样阅读和编撰一些正则表达式”。即便这么,它们常常会特别脆弱,容易失效。我们将在本书后续部份介绍更先进的抽取链接和辨识页面的形式。可以看出,问题出在下载/index/1时,该链接只有网页的路径部份,而没有合同和服务器部份,也就是说这是一个相对链接。由于浏览器晓得你正在浏览那个网页,并且还能采取必要步骤处理那些链接,因此在浏览器浏览时,相对链接是才能正常工作的。但是,urllib并没有上下文。为了使urllib才能定位网页,我们须要将链接转换为绝对链接的方式,以便包含定位网页的所有细节。如你所愿,Python的urllib中有一个模块可以拿来实现该功能,该模块名为parse。下面是link_crawler的改进版本,使用了urljoin方式来创建绝对路径。

from urllib.parse import urljoin

def link_crawler(start_url, link_regex):

""" Crawl from the given start URL following links matched by

link_regex

"""

crawl_queue = [start_url]

while crawl_queue:

url = crawl_queue.pop()

html = download(url)

if not html:

continue

for link in get_links(html):

if re.match(link_regex, link):

abs_link = urljoin(start_url, link)

crawl_queue.append(abs_link)

当你运行这段代码时,会听到似乎下载了匹配的网页,但是同样的地点总是会被不断下载到。产生该行为的诱因是那些地点互相之间存在链接。比如,澳大利亚链接到了南极洲,而南极洲又链接回了德国,此时爬虫都会继续将这种URL装入队列,永远不会抵达队列尾部

。要想避开重复爬取相同的链接,我们须要记录什么链接早已被爬取过。下面是更改后的link_crawler函数,具备了储存已发觉URL的功能,可以避免重复下载。

def link_crawler(start_url, link_regex):

crawl_queue = [start_url]

# keep track which URL's have seen before

seen = set(crawl_queue)

while crawl_queue:

url = crawl_queue.pop()

html = download(url)

if not html:

continue

for link in get_links(html):

# check if link matches expected regex

if re.match(link_regex, link):

abs_link = urljoin(start_url, link)

# check if have already seen this link

if abs_link not in seen:

seen.add(abs_link)

crawl_queue.append(abs_link)

当运行该脚本时,它会爬取所有地点,并且还能如期停止。最终,我们得到了一个可用的链接爬虫!

Python爬虫入门看哪些书好?

采集交流 • 优采云 发表了文章 • 0 个评论 • 263 次浏览 • 2020-05-30 08:02

这本书是一本实战性的网路爬虫秘籍,在本书中除了讲解了怎样编撰爬虫,还讲解了流行的网路爬虫的使用。而且这本色书的作者在Python领域有着极其深厚的积累,不仅精通Python网络爬虫,而且在Python机器学习等领域都有着丰富的实战经验,所以说这本书是Python爬虫入门人员必备的书籍。

这本书总共从三个维度讲解了Python爬虫入门,分别是:

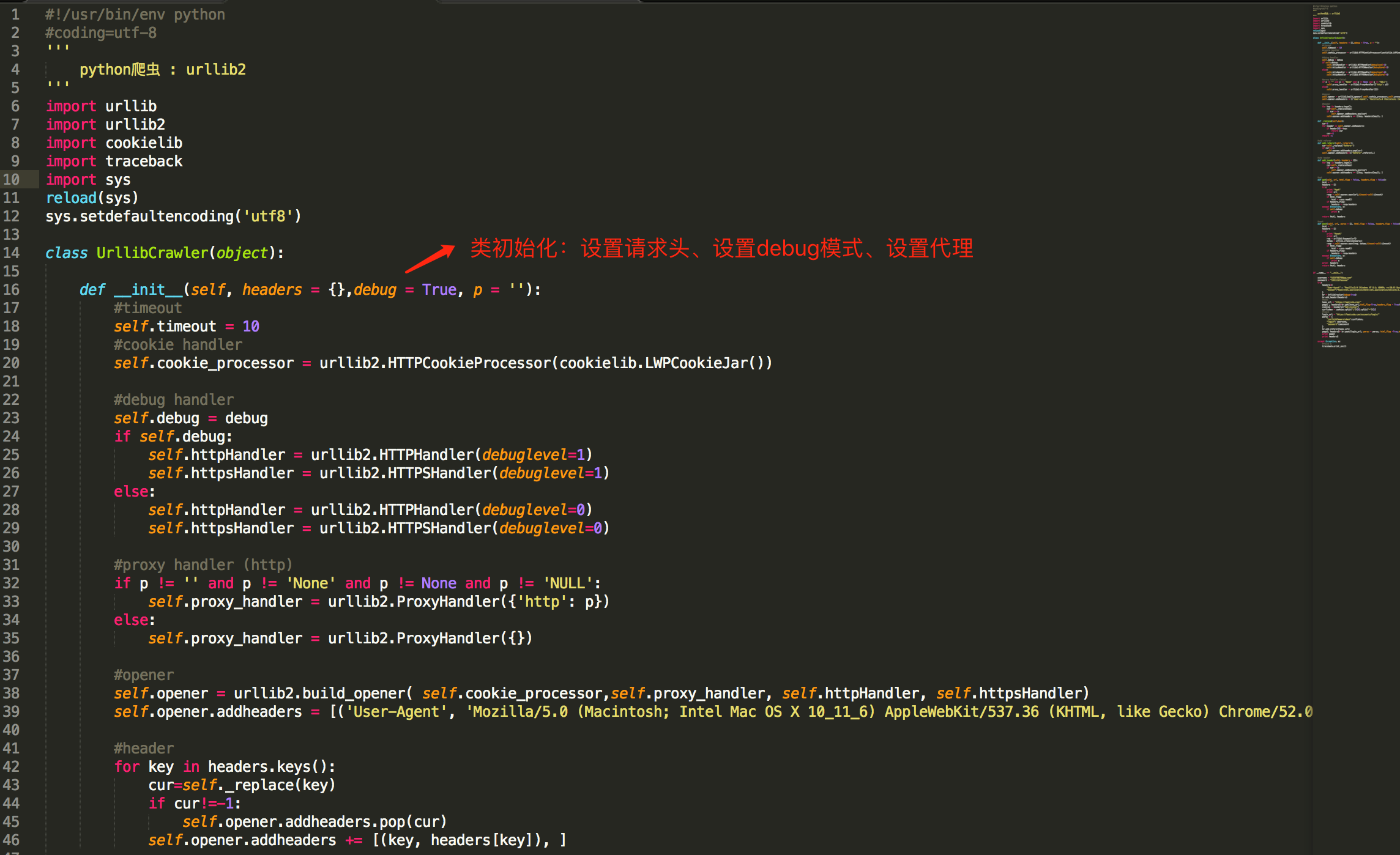

技术维度:详细讲解了Python网路爬虫实现的核心技术,包括网路爬虫的工作原理、如何用urllib库编撰网路爬虫、爬虫的异常处理、正则表达式、爬虫中Cookie的使用、爬虫的浏览器伪装技术、定向爬取技术、反爬虫技术,以及怎样自己动手编撰网路爬虫;

在学习python中有任何困难不懂的可以加入我的python交流学习群:629614370,多多交流问题,互帮互助,群里有不错的学习教程和开发工具。学习python有任何问题(学习方法,学习效率,如何就业),可以随时来咨询我。需要电子书籍的可以自己加裤下载,网盘链接不使发

工具维度:以流行的Python网路爬虫框架Scrapy为对象,详细讲解了Scrapy的功能使用、高级方法、架构设计、实现原理,以及怎样通过Scrapy来更便捷、高效地编撰网路爬虫;

实战维度:以实战为导向,是本书的主旨python爬虫经典书籍python爬虫经典书籍,除了完全通过自动编程实现网路爬虫和通过Scrapy框架实现网路爬虫的实战案例以外,本书还有博客爬取、图片爬取、模拟登陆等多个综合性的网路爬虫实践案例。 查看全部

生活在21世纪的互联网时代,各类技术的发展堪称是瞬息万变,这不明天编程界又出现一位“新星”,他的名子称作Python,目前Python早已超过Java而居于编程排名语言的第五位了。随着Python语言的火爆发展,目前很多人都在想学习Python,那么Python爬虫入门看哪些书好呢?小编为你推荐一本书,手把手教你学Python。

这本书是一本实战性的网路爬虫秘籍,在本书中除了讲解了怎样编撰爬虫,还讲解了流行的网路爬虫的使用。而且这本色书的作者在Python领域有着极其深厚的积累,不仅精通Python网络爬虫,而且在Python机器学习等领域都有着丰富的实战经验,所以说这本书是Python爬虫入门人员必备的书籍。

这本书总共从三个维度讲解了Python爬虫入门,分别是:

技术维度:详细讲解了Python网路爬虫实现的核心技术,包括网路爬虫的工作原理、如何用urllib库编撰网路爬虫、爬虫的异常处理、正则表达式、爬虫中Cookie的使用、爬虫的浏览器伪装技术、定向爬取技术、反爬虫技术,以及怎样自己动手编撰网路爬虫;

在学习python中有任何困难不懂的可以加入我的python交流学习群:629614370,多多交流问题,互帮互助,群里有不错的学习教程和开发工具。学习python有任何问题(学习方法,学习效率,如何就业),可以随时来咨询我。需要电子书籍的可以自己加裤下载,网盘链接不使发

工具维度:以流行的Python网路爬虫框架Scrapy为对象,详细讲解了Scrapy的功能使用、高级方法、架构设计、实现原理,以及怎样通过Scrapy来更便捷、高效地编撰网路爬虫;

实战维度:以实战为导向,是本书的主旨python爬虫经典书籍python爬虫经典书籍,除了完全通过自动编程实现网路爬虫和通过Scrapy框架实现网路爬虫的实战案例以外,本书还有博客爬取、图片爬取、模拟登陆等多个综合性的网路爬虫实践案例。

网络爬虫软件都有什么比较著名的?

采集交流 • 优采云 发表了文章 • 0 个评论 • 354 次浏览 • 2020-05-29 08:01

这里简单介绍3个比较实用的爬虫软件,分别是火车头、八爪鱼和后羿,对于网路大部分数据来说,都可以轻松爬取,而且不需要编撰一行代码网络爬虫软件下载,感兴趣的同学可以尝试一下:

这是Windows系统下一个特别不错的网路爬虫软件,个人使用完全免费,集成了数据的抓取、处理、分析和挖掘全过程,可以灵活抓取网页上散乱的数据,并通过一系列的剖析处理,准确挖掘出所需信息,下面我简单介绍一下这个软件:

1.首先,安装火车头采集器,这个直接在官网上下载就行,如下,安装包也就30M左右,一个exe文件,直接双击安装:

2.安装完成后,打开这个软件,主界面如下,接着我们就可以直接新建任务,设计采集规则网络爬虫软件下载,爬取网路数据了,官方自带有详尽教程(帮助指南),可供初学者学习使用,非常便捷:

这也是Windows平台下一个特别不错的爬虫软件,个人使用完全免费,内置了大量采集模板,可以轻松采集京东、天猫、大众点评等热门网站,而且不需编撰一行代码,下面我简单介绍一下这个软件:

1.首先,安装八爪鱼采集器,这个也直接到官网上下载就行,如下,一个exe安装包,直接双击安装就行:

2.安装完成后,打开这个软件,主界面如下,接着我们就可以直接定义采集方式,新建采集任务,爬取网页数据了,官网也带有入门文档和教程,非常适宜初学者学习:

这是一个免费、跨平台的网路爬虫软件,个人版完全免费,基于人工智能技术,可以智能辨识并提取出网页内容(包括列表、表格等),支持手动翻页和文件导入功能,使用上去十分便捷,下面我简单介绍一下这个软件:

1.首先,安装后羿采集器,这个也直接到官网上下载就行,如下,各个平台的版本都有,选择适宜自己平台的版本即可:

2.安装完成后,打开这个软件,主界面如下,这里我们直接输入须要采集的网页地址,软件都会手动辨识并抓取网页信息,非常智能:

目前,就分享这3个不错的网路爬虫软件吧,对于日常爬取网页数据来说,完全够用了,当然,还有许多其他爬虫软件,像造数等,也都十分不错,网上也有相关教程和资料,介绍的特别详尽,感兴趣的话,可以搜一下,希望以上分享的内容能对你有所帮助吧,也欢迎你们评论、留言进行补充。 查看全部

这里简单介绍3个比较实用的爬虫软件,分别是火车头、八爪鱼和后羿,对于网路大部分数据来说,都可以轻松爬取,而且不需要编撰一行代码网络爬虫软件下载,感兴趣的同学可以尝试一下:

这是Windows系统下一个特别不错的网路爬虫软件,个人使用完全免费,集成了数据的抓取、处理、分析和挖掘全过程,可以灵活抓取网页上散乱的数据,并通过一系列的剖析处理,准确挖掘出所需信息,下面我简单介绍一下这个软件:

1.首先,安装火车头采集器,这个直接在官网上下载就行,如下,安装包也就30M左右,一个exe文件,直接双击安装:

2.安装完成后,打开这个软件,主界面如下,接着我们就可以直接新建任务,设计采集规则网络爬虫软件下载,爬取网路数据了,官方自带有详尽教程(帮助指南),可供初学者学习使用,非常便捷:

这也是Windows平台下一个特别不错的爬虫软件,个人使用完全免费,内置了大量采集模板,可以轻松采集京东、天猫、大众点评等热门网站,而且不需编撰一行代码,下面我简单介绍一下这个软件:

1.首先,安装八爪鱼采集器,这个也直接到官网上下载就行,如下,一个exe安装包,直接双击安装就行:

2.安装完成后,打开这个软件,主界面如下,接着我们就可以直接定义采集方式,新建采集任务,爬取网页数据了,官网也带有入门文档和教程,非常适宜初学者学习:

这是一个免费、跨平台的网路爬虫软件,个人版完全免费,基于人工智能技术,可以智能辨识并提取出网页内容(包括列表、表格等),支持手动翻页和文件导入功能,使用上去十分便捷,下面我简单介绍一下这个软件:

1.首先,安装后羿采集器,这个也直接到官网上下载就行,如下,各个平台的版本都有,选择适宜自己平台的版本即可:

2.安装完成后,打开这个软件,主界面如下,这里我们直接输入须要采集的网页地址,软件都会手动辨识并抓取网页信息,非常智能:

目前,就分享这3个不错的网路爬虫软件吧,对于日常爬取网页数据来说,完全够用了,当然,还有许多其他爬虫软件,像造数等,也都十分不错,网上也有相关教程和资料,介绍的特别详尽,感兴趣的话,可以搜一下,希望以上分享的内容能对你有所帮助吧,也欢迎你们评论、留言进行补充。

网络爬虫是哪些

采集交流 • 优采云 发表了文章 • 0 个评论 • 225 次浏览 • 2020-06-15 08:01

网络爬虫介绍:

网络爬虫也可以称作网路蜘蛛,它是一种手动获取网页内容的程序,爬虫抓取的网页将会被搜索引擎系统存储,进行一定的剖析、过滤爬虫软件是什么,并且构建索引,以便以后的用户才能查询到这个页面。这个获取信息的程序就是网路爬虫程序,也可以说是网路蜘蛛程序。

网络爬虫跟搜索引擎的关系,网络爬虫是为搜索引擎搜集内容的爬虫软件是什么,搜索引擎所展示的内容大部分都是爬虫搜集的内容。而搜索引擎所展示的内容都各大网站的内容,那么搜集这种各大网站内容的程序就叫做网路爬虫程序。各大网而它们的关系,我们可以例如搜索引擎是老总,网络爬虫就是工作人员,他们的关系如同是上下级关系的。所以说网路爬虫跟搜索引擎的关系就是上下级关系。

网络爬虫是能守漫游的开式进行抓取的,网络爬虫它爬到一个页面后,看到一个链接,然后沿着那种链接又爬到另外一个页面,爬虫是不停的从一个页面跳转到另外一个页面的,它是一边下载这个网页的内容,一边在提取这个网页中的链接,那个页面上所有的链接都统一放置在一个公用的“待抓取列表”里面的。在这里说一下,网络爬虫它有一个特性,什么特征呢?

网络爬虫它在访问你网站之前,它是不会去做判定这个网页本身怎么样的,也不对网页内容判定就进行抓取的。但是有一点就是会有优先级的界定,怎么来界定的呢?就是尽可能不抓取重复的内容,尽量抓取重要的内容,对用户有用的内容,比如网站的公共部份网路蜘蛛都会尽量的不去抓取了。搜索引擎它会同时派出多个爬虫进行多线程的抓取,所有被爬虫抓取的网页都将会被系统存储,进行一定的剖析、过滤、去重。并构建索引,以便以后的查询和检索。

网络爬虫的分类:

网络爬虫他有好几种,我们可以按照搜索引擎来进行分类,可以分以下几种,比如:

1、百度的爬虫我们叫Baiduspider也称作百度蜘蛛

2、谷歌的爬虫我们叫Googlebot也称作微软机器人

3、SOSO爬虫我们叫sosospider