网站内容抓取

避开抓取陷阱的目的是克服网站阻止自动抓取这个障碍

网站优化 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2021-07-03 19:37

避免爬虫陷阱的目的是克服网站防止自动爬虫。

1.道德标准

注意:此处演示的许多程序和技术不应用于任何网站。这不仅很糟糕,而且您还可能会收到一封警告信,要求您停止,甚至可能会发生更糟糕的事情。

2.让网络机器人看起来像人类用户

网站反爬虫的前提是正确区分人类用户和网络机器人。有很多方法可以让您的网络机器人看起来更像人类用户。

(1)Modify 请求头

HTTP 请求头是每次向 Web 服务器发送请求时传递的一组属性或配置信息。 HTTP 请求有多种类型。大多数浏览器仅使用这 7 个字段来初始化所有网络请求:Host、Connection、Accept、User-Agent、Referrer、Accept-Encoding、Accept-Language。经典的 Python 爬虫在使用 urllib 标准库时会发送 Accept-Encoding 和 User-Agent。

可以使用 Requests 库配置请求标头。

书中代码:(执行被拦截,如果执行成功:程序输出中的请求头应该和程序中设置的头一致。)

import requests

from bs4 import BeautifulSoup

session = requests.Session()

headers = {'User-Agent':'Mozilla/5.0(Macintosh; Intel Mac OS X 10_9_5)AppleWebKit 537.36 (KHTML, like Gecko) Chrome', 'Accept':'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8'}

url = 'https://www.whatismybrowser.co ... 39%3B

req = session.get(url, headers=headers)

bs = BeautifulSoup(req.text, 'html.parser')

print(bs.find('table', {'class':'table-striped'}).get_text)

也许网站会检查HTTP请求头的每一个属性,通常真正重要的参数是User-Agent。不管你在做什么项目,一定要记得把User-Agent属性设置成不容易引起怀疑的东西,不要使用Python-urllib/3.4。对于非常警觉的网站,注意那些经常使用但很少检查的请求头,比如Accept-Language属性。

很多大的网站会为相同的内容提供不同的语言翻译,根据请求头的参数响应不同的语言版本。有时只需要将请求头属性从 Accept-Language:en-US 修改为 Accept-Language:fr 即可获得法语版本的页面。请求头也可以让网站改变内容的布局风格,修改User-Agent。

(2)使用JavaScript处理cookies

通过正确处理 cookie,可以避免许多抓取问题。 网站 将使用 cookie 来跟踪您的访问。如果发现有异常行为的爬虫,其访问将被中断,例如非常快速地填写表格,或浏览大量页面。

有些网站 不需要您每次登录时都获取新的 cookie。您可以通过保存旧的“登录”cookie 来访问 网站。

某些浏览器插件可以显示您访问网站 和浏览网站 时cookie 是如何设置的。 (EditThisCookie)

Requests模块对cookies的处理请参考第十章文章5th小节内容。

请求库无法执行 JavaScript,因此无法处理现代跟踪软件(例如 Google Analytics)生成的许多 cookie。 cookie 仅在客户端脚本执行时设置(或根据用户浏览页面时按钮点击等 Web 事件生成 cookie)。需要用到Selenium和PhantomJS包(安装和使用在第11章文章)

使用任意网站调用webdriver的get_cookie()方法查看cookies(cookie列表):

from selenium import webdriver

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com')

driver.implicitly_wait(1)

print(driver.get_cookies())

您还可以调用 delete_cookie()、add_cookie() 和 delete_all_cookies() 方法来处理 cookie。此外,可以保存 cookie 以供其他网络爬虫使用。 (driver2的cookies打印失败,找不到原因)

# -*- coding:GBK -*-

from selenium import webdriver

#driver = webdriver.Chrome(r'C:\Users\Administrator\AppData\Local\Google\Chrome\Application\chromedriver.exe')

# 尝试webdriver.PhantomJS()内添加service_args=['--ignore-ssl-errors=true', '--ssl-protocol=TLSv1'],扔执行失败

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com')

driver.implicitly_wait(1)

savedCookies = driver.get_cookies()

print(savedCookies)

#driver2 = webdriver.Chrome(r'C:\Users\Administrator\AppData\Local\Google\Chrome\Application\chromedriver.exe')

driver2 = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver2.get('http://pythonscraping.com')

driver2.delete_all_cookies()

for cookie in savedCookies:

if not cookie['domain'].startswith('.'):

cookie['domain'] = '.{}'.format(cookie['domain']) #PhantomJS的规则——添加cookie的所有域名都要以.字符开头

driver2.add_cookie(cookie)

driver2.get('http://pythonscraping.com')

driver.implicitly_wait(1)

print(driver2.get_cookies())

(3)时间就是一切

一些具有完整保护措施的网站可能会阻止您快速提交表单或与网站快速交互。以比普通人快得多的速度从网站下载大量信息,也可能导致自己被网站屏蔽。

多线程程序可能是快速加载页面的好方法,但这对于编写良好的爬虫来说仍然是一个糟糕的策略。应该尽量确保页面加载和数据请求最小化。如果可能,尝试在页面访问之间添加几秒钟(使用以下代码)。有时候,我们必须学会撤退!

import time

time.sleep(3)

3.通用表单安全措施

Web 表单,尤其是用于创建和登录帐户的表单,如果被机器人滥用,将对网站 的安全性和计算开销构成严重威胁。因此,试图限制网站 的访问是最适合许多网站 所有者的利益。 (有关处理受保护表单的更多信息,请参阅第 13 部分和第 17 部分)

(1)隐式输入字段值

在HTML表单中,“隐藏”字段用于使该字段的值对浏览器可见,但对用户不可见(除非你看到

网页源代码)。

有两种主要方法可以阻止带有隐藏字段的网络爬行:

第一个是表单页面上的一个字段可以填充由服务器生成的随机变量。 (规避这个问题最好的办法是先抓取表单所在页面生成的随机变量,然后提交到表单处理页面。)

第二种方法是“蜜罐”。服务器会忽略所有隐藏字段的真实值(或表单提交页面上与默认值不同的值),填写隐藏字段的用户甚至可能被网站屏蔽。总之,有时候需要检查一下表单所在的页面,看看有没有服务器预设的隐藏字段(蜜罐陷阱)缺失或者错误。此外,还有其他检查可以用来确保当前生成的表单变量只使用过一次或最近生成过(这可以防止变量简单地存储在程序中重复使用)。

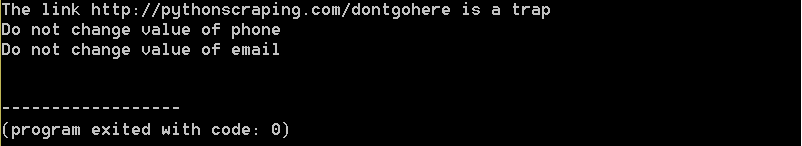

(2)避免蜜罐

如果web表单的某个字段通过CSS设置为用户不可见,那么普通用户在访问网站时无法填写该字段。如果填写了这个字段,很可能是机器人做了,所以这个提交会作废。这种方法也适用于链接、图片、文件以及任何机器人可以读取但普通用户在浏览器中看不到的内容。

查看网站的源码,通过CSS隐藏了一个链接(属性设置display:none)和两个隐藏字段(type="hidden",元素移动到了显示和滚动的边界之外bar 被隐藏,导致元素不可见)。

Selenium 可以获取访问页面的内容,因此可以区分页面上的可见元素和隐藏元素。使用 is_displayed() 判断该元素在页面上是否可见。

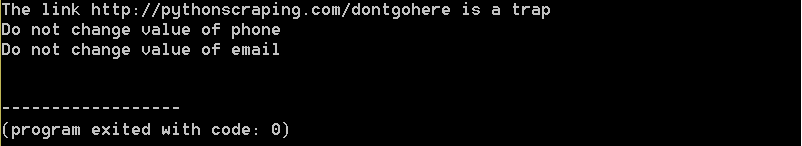

以下代码查找上面网站的隐藏元素:

from selenium import webdriver

from selenium.webdriver.remote.webelement import WebElement

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com/page ... %2339;)

links = driver.find_elements_by_tag_name('a')

for link in links:

if not link.is_displayed():

print('The link {} is a trap'.format(link.get_attribute('href')))

fields = driver.find_elements_by_tag_name('input')

for field in fields:

if not field.is_displayed():

print('Do not change value of {}'.format(field.get_attribute('name')))

简而言之,简单地忽略隐藏字段是危险的,但在与它们交互时必须小心。

4.问题清单 查看全部

避开抓取陷阱的目的是克服网站阻止自动抓取这个障碍

避免爬虫陷阱的目的是克服网站防止自动爬虫。

1.道德标准

注意:此处演示的许多程序和技术不应用于任何网站。这不仅很糟糕,而且您还可能会收到一封警告信,要求您停止,甚至可能会发生更糟糕的事情。

2.让网络机器人看起来像人类用户

网站反爬虫的前提是正确区分人类用户和网络机器人。有很多方法可以让您的网络机器人看起来更像人类用户。

(1)Modify 请求头

HTTP 请求头是每次向 Web 服务器发送请求时传递的一组属性或配置信息。 HTTP 请求有多种类型。大多数浏览器仅使用这 7 个字段来初始化所有网络请求:Host、Connection、Accept、User-Agent、Referrer、Accept-Encoding、Accept-Language。经典的 Python 爬虫在使用 urllib 标准库时会发送 Accept-Encoding 和 User-Agent。

可以使用 Requests 库配置请求标头。

书中代码:(执行被拦截,如果执行成功:程序输出中的请求头应该和程序中设置的头一致。)

import requests

from bs4 import BeautifulSoup

session = requests.Session()

headers = {'User-Agent':'Mozilla/5.0(Macintosh; Intel Mac OS X 10_9_5)AppleWebKit 537.36 (KHTML, like Gecko) Chrome', 'Accept':'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8'}

url = 'https://www.whatismybrowser.co ... 39%3B

req = session.get(url, headers=headers)

bs = BeautifulSoup(req.text, 'html.parser')

print(bs.find('table', {'class':'table-striped'}).get_text)

也许网站会检查HTTP请求头的每一个属性,通常真正重要的参数是User-Agent。不管你在做什么项目,一定要记得把User-Agent属性设置成不容易引起怀疑的东西,不要使用Python-urllib/3.4。对于非常警觉的网站,注意那些经常使用但很少检查的请求头,比如Accept-Language属性。

很多大的网站会为相同的内容提供不同的语言翻译,根据请求头的参数响应不同的语言版本。有时只需要将请求头属性从 Accept-Language:en-US 修改为 Accept-Language:fr 即可获得法语版本的页面。请求头也可以让网站改变内容的布局风格,修改User-Agent。

(2)使用JavaScript处理cookies

通过正确处理 cookie,可以避免许多抓取问题。 网站 将使用 cookie 来跟踪您的访问。如果发现有异常行为的爬虫,其访问将被中断,例如非常快速地填写表格,或浏览大量页面。

有些网站 不需要您每次登录时都获取新的 cookie。您可以通过保存旧的“登录”cookie 来访问 网站。

某些浏览器插件可以显示您访问网站 和浏览网站 时cookie 是如何设置的。 (EditThisCookie)

Requests模块对cookies的处理请参考第十章文章5th小节内容。

请求库无法执行 JavaScript,因此无法处理现代跟踪软件(例如 Google Analytics)生成的许多 cookie。 cookie 仅在客户端脚本执行时设置(或根据用户浏览页面时按钮点击等 Web 事件生成 cookie)。需要用到Selenium和PhantomJS包(安装和使用在第11章文章)

使用任意网站调用webdriver的get_cookie()方法查看cookies(cookie列表):

from selenium import webdriver

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com')

driver.implicitly_wait(1)

print(driver.get_cookies())

您还可以调用 delete_cookie()、add_cookie() 和 delete_all_cookies() 方法来处理 cookie。此外,可以保存 cookie 以供其他网络爬虫使用。 (driver2的cookies打印失败,找不到原因)

# -*- coding:GBK -*-

from selenium import webdriver

#driver = webdriver.Chrome(r'C:\Users\Administrator\AppData\Local\Google\Chrome\Application\chromedriver.exe')

# 尝试webdriver.PhantomJS()内添加service_args=['--ignore-ssl-errors=true', '--ssl-protocol=TLSv1'],扔执行失败

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com')

driver.implicitly_wait(1)

savedCookies = driver.get_cookies()

print(savedCookies)

#driver2 = webdriver.Chrome(r'C:\Users\Administrator\AppData\Local\Google\Chrome\Application\chromedriver.exe')

driver2 = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver2.get('http://pythonscraping.com')

driver2.delete_all_cookies()

for cookie in savedCookies:

if not cookie['domain'].startswith('.'):

cookie['domain'] = '.{}'.format(cookie['domain']) #PhantomJS的规则——添加cookie的所有域名都要以.字符开头

driver2.add_cookie(cookie)

driver2.get('http://pythonscraping.com')

driver.implicitly_wait(1)

print(driver2.get_cookies())

(3)时间就是一切

一些具有完整保护措施的网站可能会阻止您快速提交表单或与网站快速交互。以比普通人快得多的速度从网站下载大量信息,也可能导致自己被网站屏蔽。

多线程程序可能是快速加载页面的好方法,但这对于编写良好的爬虫来说仍然是一个糟糕的策略。应该尽量确保页面加载和数据请求最小化。如果可能,尝试在页面访问之间添加几秒钟(使用以下代码)。有时候,我们必须学会撤退!

import time

time.sleep(3)

3.通用表单安全措施

Web 表单,尤其是用于创建和登录帐户的表单,如果被机器人滥用,将对网站 的安全性和计算开销构成严重威胁。因此,试图限制网站 的访问是最适合许多网站 所有者的利益。 (有关处理受保护表单的更多信息,请参阅第 13 部分和第 17 部分)

(1)隐式输入字段值

在HTML表单中,“隐藏”字段用于使该字段的值对浏览器可见,但对用户不可见(除非你看到

网页源代码)。

有两种主要方法可以阻止带有隐藏字段的网络爬行:

第一个是表单页面上的一个字段可以填充由服务器生成的随机变量。 (规避这个问题最好的办法是先抓取表单所在页面生成的随机变量,然后提交到表单处理页面。)

第二种方法是“蜜罐”。服务器会忽略所有隐藏字段的真实值(或表单提交页面上与默认值不同的值),填写隐藏字段的用户甚至可能被网站屏蔽。总之,有时候需要检查一下表单所在的页面,看看有没有服务器预设的隐藏字段(蜜罐陷阱)缺失或者错误。此外,还有其他检查可以用来确保当前生成的表单变量只使用过一次或最近生成过(这可以防止变量简单地存储在程序中重复使用)。

(2)避免蜜罐

如果web表单的某个字段通过CSS设置为用户不可见,那么普通用户在访问网站时无法填写该字段。如果填写了这个字段,很可能是机器人做了,所以这个提交会作废。这种方法也适用于链接、图片、文件以及任何机器人可以读取但普通用户在浏览器中看不到的内容。

查看网站的源码,通过CSS隐藏了一个链接(属性设置display:none)和两个隐藏字段(type="hidden",元素移动到了显示和滚动的边界之外bar 被隐藏,导致元素不可见)。

Selenium 可以获取访问页面的内容,因此可以区分页面上的可见元素和隐藏元素。使用 is_displayed() 判断该元素在页面上是否可见。

以下代码查找上面网站的隐藏元素:

from selenium import webdriver

from selenium.webdriver.remote.webelement import WebElement

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com/page ... %2339;)

links = driver.find_elements_by_tag_name('a')

for link in links:

if not link.is_displayed():

print('The link {} is a trap'.format(link.get_attribute('href')))

fields = driver.find_elements_by_tag_name('input')

for field in fields:

if not field.is_displayed():

print('Do not change value of {}'.format(field.get_attribute('name')))

简而言之,简单地忽略隐藏字段是危险的,但在与它们交互时必须小心。

4.问题清单

图片到底是怎么抓取的呢?图片优化是个细节问题

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-07-03 06:40

一个网站如果所有密集的文本对用户体验非常不利,同时我不想在网站上停留一分钟或一秒钟。 网站在开发的时候,会在页面上加很多图片来美化和体验更好,但是图片对于搜索引擎的蜘蛛爬行能力不如文章,文字少,很多图片。会对seo优化造成一定的困难。

图片是如何拍摄的?

1、 是最好的原创 图片。图片还是自己做的。您可以使用免费图片拼接成我们想要的图片。请勿盗图。

<p>2.为了方便蜘蛛爬取,上传图片到网站时,最好将所有图片按照网站一栏放在对应的图片目录,或者放在一个文件夹中。 查看全部

图片到底是怎么抓取的呢?图片优化是个细节问题

一个网站如果所有密集的文本对用户体验非常不利,同时我不想在网站上停留一分钟或一秒钟。 网站在开发的时候,会在页面上加很多图片来美化和体验更好,但是图片对于搜索引擎的蜘蛛爬行能力不如文章,文字少,很多图片。会对seo优化造成一定的困难。

图片是如何拍摄的?

1、 是最好的原创 图片。图片还是自己做的。您可以使用免费图片拼接成我们想要的图片。请勿盗图。

<p>2.为了方便蜘蛛爬取,上传图片到网站时,最好将所有图片按照网站一栏放在对应的图片目录,或者放在一个文件夹中。

彻底解决网站内容的收集和捕获要解决企业网站的收录问题

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-07-03 06:30

通过做网站,只有彻底解决网站的收录和抓取问题,才能最大化网站的价值,实现这样的网站内容不管数量还是质量。以上有待改进。 网站 结构对用户和蜘蛛都有利,因为蜘蛛和用户相辅相成。只有通过网站同时满足要求才是好的网站。

彻底解决网站内容的采集和抓取

解决企业网站的收录问题,首先要制定步骤,了解学生搜索引擎蜘蛛的工作方法。首先,蜘蛛需要到达你的网站,所以除了固定蜘蛛来的方式外,我们还可以主动引导他抓取我们的内容,如果没有抓到我们,我们可以主动提交给他。 (善用百度站长平台的主动提交、手动提交和站点地图)

彻底解决网站内容的采集和抓取

蜘蛛到达我们的网站。对于我们的国家,我们仍然需要让他高兴地抓住它。这涉及到网站主要内容的可识别性,下载页面设计能否顺利下载,产品信息页面是否描述清楚等等。

彻底解决网站内容的采集和抓取

蜘蛛抓取成功后,会将内容放入索引库中进行过滤比较,然后在用户搜索相关关键词时显示出来。索引就是我们通常所说的收录、收录,它只是表示你的页面存在于搜索引擎的索引库中,并不代表它被显示出来。

重要的是蜘蛛是否会抓取您的页面,是否会抓取高质量的页面,以及客户搜索关键字时您的页面是否是其他页面中最好的。

要搭好路桥,我们要做的就是提高学生自营业务网站的内容质量,让搜索引擎蜘蛛在以用户为中心的基础上更好的被抓。

最后,如果你对SEO优化感兴趣,不了解网站optimization推广,私信回复“数据”,我会给你发送3.7G软件包和内部SEO优化课程让你进入SEO这条路可以少走一点弯路,哪怕只有一点 查看全部

彻底解决网站内容的收集和捕获要解决企业网站的收录问题

通过做网站,只有彻底解决网站的收录和抓取问题,才能最大化网站的价值,实现这样的网站内容不管数量还是质量。以上有待改进。 网站 结构对用户和蜘蛛都有利,因为蜘蛛和用户相辅相成。只有通过网站同时满足要求才是好的网站。

彻底解决网站内容的采集和抓取

解决企业网站的收录问题,首先要制定步骤,了解学生搜索引擎蜘蛛的工作方法。首先,蜘蛛需要到达你的网站,所以除了固定蜘蛛来的方式外,我们还可以主动引导他抓取我们的内容,如果没有抓到我们,我们可以主动提交给他。 (善用百度站长平台的主动提交、手动提交和站点地图)

彻底解决网站内容的采集和抓取

蜘蛛到达我们的网站。对于我们的国家,我们仍然需要让他高兴地抓住它。这涉及到网站主要内容的可识别性,下载页面设计能否顺利下载,产品信息页面是否描述清楚等等。

彻底解决网站内容的采集和抓取

蜘蛛抓取成功后,会将内容放入索引库中进行过滤比较,然后在用户搜索相关关键词时显示出来。索引就是我们通常所说的收录、收录,它只是表示你的页面存在于搜索引擎的索引库中,并不代表它被显示出来。

重要的是蜘蛛是否会抓取您的页面,是否会抓取高质量的页面,以及客户搜索关键字时您的页面是否是其他页面中最好的。

要搭好路桥,我们要做的就是提高学生自营业务网站的内容质量,让搜索引擎蜘蛛在以用户为中心的基础上更好的被抓。

最后,如果你对SEO优化感兴趣,不了解网站optimization推广,私信回复“数据”,我会给你发送3.7G软件包和内部SEO优化课程让你进入SEO这条路可以少走一点弯路,哪怕只有一点

网页里注释的内容会被百度抓取分析吗?(图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2021-06-28 05:54

很多站长都知道网页代码里有评论代码。形式是HTML中的注释内容出现在网页的源代码中,用户在浏览网页时是看不到的。因为源码中显示的注解内容不会影响页面的内容,很多人认为蜘蛛会抓取注解信息参与网页的分析和排名,所以添加了大量的注解内容到网页,甚至直接在注解里堆关键词。 .

网页上的评论内容会被抓取吗?我们来看看百度工程师是如何回答的:

问:评论内容会被百度抓取分析吗?

百度工程师:在文本提取过程中会忽略html中的评论内容。注释的代码虽然不会被爬取,但也会造成代码繁琐,所以可以尽量少。

显然,搜索引擎蜘蛛非常聪明。他们可以在网络爬虫过程中识别注释信息并直接忽略它。因此,注释内容不会被抓取,也不会参与网页内容的分析。进去试想一下,如果蜘蛛可以抓取评论,而这个评论代码就相当于一种隐藏的文字,那么网站主内容就可以被JS代码调用,只供用户浏览,把你想要的内容都放上去抓取的蜘蛛有大量的注释信息,使网页向蜘蛛和用户展示不同的内容。如果你是灰色行业网站,那么你可以给搜索引擎一个完全正规的内容展示,摆脱搜索引擎的束缚,搜索引擎会不会正式允许你作弊?所以不管你在评论里加多少关键词,都不会影响排名。

评论里加关键词会影响排名吗?不会是因为搜索引擎直接忽略了注释,而是如何注释大量内容会影响网页的风格,影响网页的加载速度。因此,如果注释没有用,请尝试删除它们并尽可能保持代码简单。我们经常谈论网站code 减肥。简化标注信息是减肥的方法之一。优化注解信息对网站瘦身有利。

当然,很多程序员和网页设计师都习惯于给网页添加注释信息。这是一个好习惯。合理的注解信息可以减少查找信息的时间,使代码的查询和修改更加方便,所以建议在线网页简单地添加注解信息,比如网页各部分的头尾注解,重要的内容部分注释等,离线备份网页可以更详细地添加每个部分的注释信息,方便技术人员浏览和修改,不仅有利于网页瘦身,而且不影响未来的网页修改。 查看全部

网页里注释的内容会被百度抓取分析吗?(图)

很多站长都知道网页代码里有评论代码。形式是HTML中的注释内容出现在网页的源代码中,用户在浏览网页时是看不到的。因为源码中显示的注解内容不会影响页面的内容,很多人认为蜘蛛会抓取注解信息参与网页的分析和排名,所以添加了大量的注解内容到网页,甚至直接在注解里堆关键词。 .

网页上的评论内容会被抓取吗?我们来看看百度工程师是如何回答的:

问:评论内容会被百度抓取分析吗?

百度工程师:在文本提取过程中会忽略html中的评论内容。注释的代码虽然不会被爬取,但也会造成代码繁琐,所以可以尽量少。

显然,搜索引擎蜘蛛非常聪明。他们可以在网络爬虫过程中识别注释信息并直接忽略它。因此,注释内容不会被抓取,也不会参与网页内容的分析。进去试想一下,如果蜘蛛可以抓取评论,而这个评论代码就相当于一种隐藏的文字,那么网站主内容就可以被JS代码调用,只供用户浏览,把你想要的内容都放上去抓取的蜘蛛有大量的注释信息,使网页向蜘蛛和用户展示不同的内容。如果你是灰色行业网站,那么你可以给搜索引擎一个完全正规的内容展示,摆脱搜索引擎的束缚,搜索引擎会不会正式允许你作弊?所以不管你在评论里加多少关键词,都不会影响排名。

评论里加关键词会影响排名吗?不会是因为搜索引擎直接忽略了注释,而是如何注释大量内容会影响网页的风格,影响网页的加载速度。因此,如果注释没有用,请尝试删除它们并尽可能保持代码简单。我们经常谈论网站code 减肥。简化标注信息是减肥的方法之一。优化注解信息对网站瘦身有利。

当然,很多程序员和网页设计师都习惯于给网页添加注释信息。这是一个好习惯。合理的注解信息可以减少查找信息的时间,使代码的查询和修改更加方便,所以建议在线网页简单地添加注解信息,比如网页各部分的头尾注解,重要的内容部分注释等,离线备份网页可以更详细地添加每个部分的注释信息,方便技术人员浏览和修改,不仅有利于网页瘦身,而且不影响未来的网页修改。

php中抓取网页内容的实例详解方法一:使用file_get_contents方法实现代码很简单

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-06-26 18:17

php中抓取网页内容的实例详解方法一:使用file_get_contents方法实现代码很简单

php抓取网页内容的详细例子

方法一:

使用file_get_contents方法实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$html = file_get_contents($url);

//如果出现中文乱码使用下面代码

//$getcontent = iconv("gb2312", "utf-8",$html);

echo "".$html."";

代码很简单,一看就懂,就不解释了。

方法二:

使用curl来实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

echo "".$html."";

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

添加此代码表示如果请求被重定向,则可以访问最终的请求页面,否则请求结果将显示如下内容:

相关学习推荐:php编程(视频)

以上是php爬取网页内容示例的详细内容。更多详情请关注php中文网其他相关文章!

免责声明:本文转载于:jb51,如有侵权,请联系删除 查看全部

php中抓取网页内容的实例详解方法一:使用file_get_contents方法实现代码很简单

php抓取网页内容的详细例子

方法一:

使用file_get_contents方法实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$html = file_get_contents($url);

//如果出现中文乱码使用下面代码

//$getcontent = iconv("gb2312", "utf-8",$html);

echo "".$html."";

代码很简单,一看就懂,就不解释了。

方法二:

使用curl来实现

$url = "http://news.sina.com.cn/c/nd/2 ... 3B%3B

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10);

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

$html = curl_exec($ch);

curl_close($ch);

echo "".$html."";

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, 1);

添加此代码表示如果请求被重定向,则可以访问最终的请求页面,否则请求结果将显示如下内容:

相关学习推荐:php编程(视频)

以上是php爬取网页内容示例的详细内容。更多详情请关注php中文网其他相关文章!

免责声明:本文转载于:jb51,如有侵权,请联系删除

搜索引擎到底喜欢什么样的网站,优化过度只会适得其反

网站优化 • 优采云 发表了文章 • 0 个评论 • 101 次浏览 • 2021-06-26 18:11

最近和一些搞SEO的朋友讨论,网站搜索引擎喜欢什么样的。如果SEO做得合理,搜索引擎会非常喜欢,但网站过度优化只会适得其反。合理优化有利于搜索引擎抓取网站、收录更多有用的网页,挖掘出更多有价值的信息等;这样的网站被称为搜索引擎友好的网站。

最近学到了很多关于SEO的知识,我清楚地意识到在网站optimization之前,我们必须先设计一个我喜欢的网站搜索引擎,以便快速收录和排名。

如果我们从搜索引擎蜘蛛的角度来看网站,我们在爬取、索引、排序的时候会遇到什么问题,从而解决这些问题,比如网站就是搜索引擎友好的网站。和朋友讨论后,我总结出以下几点:

一、确保搜索引擎可以抓取网页

我们都知道百度蜘蛛爬到页面,通过跟踪链接抓取页面内容。如果想让蜘蛛爬到你的网站homepage,你的网站homepage必须有外链,只有蜘蛛爬到首页后,跟着内链去抓取更多更深的网站内容,

这里需要注意的是网站content页面不要离首页太远,控制在3-4次以内。

所以网站应该有一个很好的网站结构,逻辑清晰,内部链接应该形成蜘蛛网,增加蜘蛛爬行粘度。

需要注意的是,使用js脚本链接、flash链接等的搜索引擎蜘蛛一般无法跟踪爬取,因为蜘蛛无法识别,会造成收录问题。

二、找到页面后可以抓取页面内容吗?

我们吸引蜘蛛爬到网站后,文章能否顺利爬取也与你的网站设计密切相关。首先,蜘蛛不喜欢动态网址,所以找到的网址一定是可以爬取的,最好使用静态网站URL。

许多网站在整个页面中使用Flash特效,以使页面看起来更高。还有一些框架结构,当然现在很少了。对于可疑的重定向,搜索引擎建议使用 301 重定向。当然,只有旧域可以重定向到新域。 网站有很多搜索引擎不喜欢的复制内容等。

三、抓取页面后如何提取有用信息

通过学习搜索引擎的工作原理,搜索引擎蜘蛛来找你网站并抓取页面后,索引的第一步就是提取中文,所以关键词应该放在最重要的位置这页纸。那就是Title的写法,页面标题是SEO最重要的因素,一些重要标签如网站description标签和文章title标签的写法,内容一定要能够突出重点网站。

简化代码,去掉一些无用的代码或注释,可以帮助搜索引擎更快更清晰地理解页面内容,提取有用信息。

以上是网站设计的一些对搜索引擎友好的方法。我们可以把自己想象成蜘蛛。换一种方式想一想。只有我们对搜索引擎好,搜索引擎才会对我们好,对吧? 查看全部

搜索引擎到底喜欢什么样的网站,优化过度只会适得其反

最近和一些搞SEO的朋友讨论,网站搜索引擎喜欢什么样的。如果SEO做得合理,搜索引擎会非常喜欢,但网站过度优化只会适得其反。合理优化有利于搜索引擎抓取网站、收录更多有用的网页,挖掘出更多有价值的信息等;这样的网站被称为搜索引擎友好的网站。

最近学到了很多关于SEO的知识,我清楚地意识到在网站optimization之前,我们必须先设计一个我喜欢的网站搜索引擎,以便快速收录和排名。

如果我们从搜索引擎蜘蛛的角度来看网站,我们在爬取、索引、排序的时候会遇到什么问题,从而解决这些问题,比如网站就是搜索引擎友好的网站。和朋友讨论后,我总结出以下几点:

一、确保搜索引擎可以抓取网页

我们都知道百度蜘蛛爬到页面,通过跟踪链接抓取页面内容。如果想让蜘蛛爬到你的网站homepage,你的网站homepage必须有外链,只有蜘蛛爬到首页后,跟着内链去抓取更多更深的网站内容,

这里需要注意的是网站content页面不要离首页太远,控制在3-4次以内。

所以网站应该有一个很好的网站结构,逻辑清晰,内部链接应该形成蜘蛛网,增加蜘蛛爬行粘度。

需要注意的是,使用js脚本链接、flash链接等的搜索引擎蜘蛛一般无法跟踪爬取,因为蜘蛛无法识别,会造成收录问题。

二、找到页面后可以抓取页面内容吗?

我们吸引蜘蛛爬到网站后,文章能否顺利爬取也与你的网站设计密切相关。首先,蜘蛛不喜欢动态网址,所以找到的网址一定是可以爬取的,最好使用静态网站URL。

许多网站在整个页面中使用Flash特效,以使页面看起来更高。还有一些框架结构,当然现在很少了。对于可疑的重定向,搜索引擎建议使用 301 重定向。当然,只有旧域可以重定向到新域。 网站有很多搜索引擎不喜欢的复制内容等。

三、抓取页面后如何提取有用信息

通过学习搜索引擎的工作原理,搜索引擎蜘蛛来找你网站并抓取页面后,索引的第一步就是提取中文,所以关键词应该放在最重要的位置这页纸。那就是Title的写法,页面标题是SEO最重要的因素,一些重要标签如网站description标签和文章title标签的写法,内容一定要能够突出重点网站。

简化代码,去掉一些无用的代码或注释,可以帮助搜索引擎更快更清晰地理解页面内容,提取有用信息。

以上是网站设计的一些对搜索引擎友好的方法。我们可以把自己想象成蜘蛛。换一种方式想一想。只有我们对搜索引擎好,搜索引擎才会对我们好,对吧?

宇云RSS阅读器安装.xml文件安装说明

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-06-26 18:07

【基本介绍】宇云RSS阅读器是一款基于ABOBE AIR平台的RSS阅读器。不仅容量只有400多KB,软件还内置了各大门户网站的RSS新闻,分类清晰,分类多,我们采集了各大网站的RSS新闻约1000种k14@,让你足不出户,足不出户买报刊,掌控全球新闻。另外,软件支持可配置性,即用户直接修改软件目录下的assetsdatass.xml,即可手动配置自己喜欢看的RSS新闻。所以功能非常强大,方便喜欢看网络新闻的朋友采集本软件。 【软件特点】 修复说明:由于宇云RSS阅读器V1.0是基于Flex架构编写的,部署后存在一些安全沙箱问题。导致用户无法很好地使用该软件,特此修改了该版本。并对导致用户下载1.0版本无法正常使用表示诚挚的歉意。 【使用方法】安装说明:1. 请运行Adobe的AdobeAIRInstaller.exe安装Adobe AIR软件,然后打开Main.AIR文件进行安装。或者到adobe官方网站下载最新版的Adobe AIR,下载地址为:2.下载后直接安装AIR。3.即可打开Main.air文件。如果在安装过程中需要设置密码,请输入密码:1234564. 如果您的宇云RSS阅读器未注册购买软件激活码,只能查看网易头条,之后可以查看所有新闻购买和激活。 5.如果您有任何问题,请与我联系。联系人:黄晓云邮箱: 查看全部

宇云RSS阅读器安装.xml文件安装说明

【基本介绍】宇云RSS阅读器是一款基于ABOBE AIR平台的RSS阅读器。不仅容量只有400多KB,软件还内置了各大门户网站的RSS新闻,分类清晰,分类多,我们采集了各大网站的RSS新闻约1000种k14@,让你足不出户,足不出户买报刊,掌控全球新闻。另外,软件支持可配置性,即用户直接修改软件目录下的assetsdatass.xml,即可手动配置自己喜欢看的RSS新闻。所以功能非常强大,方便喜欢看网络新闻的朋友采集本软件。 【软件特点】 修复说明:由于宇云RSS阅读器V1.0是基于Flex架构编写的,部署后存在一些安全沙箱问题。导致用户无法很好地使用该软件,特此修改了该版本。并对导致用户下载1.0版本无法正常使用表示诚挚的歉意。 【使用方法】安装说明:1. 请运行Adobe的AdobeAIRInstaller.exe安装Adobe AIR软件,然后打开Main.AIR文件进行安装。或者到adobe官方网站下载最新版的Adobe AIR,下载地址为:2.下载后直接安装AIR。3.即可打开Main.air文件。如果在安装过程中需要设置密码,请输入密码:1234564. 如果您的宇云RSS阅读器未注册购买软件激活码,只能查看网易头条,之后可以查看所有新闻购买和激活。 5.如果您有任何问题,请与我联系。联系人:黄晓云邮箱:

网站内容抓取到达后台页面,页面的内容需要用吗?

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-06-26 05:01

网站内容抓取到达后台页面,页面的内容需要用html5,然后在前端转换成纯javascript格式的javascript文件,

两个东西都不是问题,反正把后台数据结构做成json格式一样可以抓包。但你在asp上直接做这个肯定是不行的,首先asp虽然有调用系统的mfc等框架写接口但是好像接口体积都蛮大,还有就是不如开发一个servlet,或者webapp就直接把数据传过去了(当然asp做出来肯定要不像app那么精简)。如果你是给厂商给个psd文件供开发人员用那你觉得可以,或者你要给机器自己做就没法搞了。

有jsp的asp,

sina有w3capi,做个app你可以到,

根据你的app内容需求来定吧。一般程序员接触最多的无非页面的展示抓取,内容抓取和页面的抓取,无论这几种都是比较简单的应用。一般而言最简单的方法就是直接使用开发机制下的api。当然在app中,最基本的有一个android类似的东西来做页面的跳转,把用户可看到的内容跳转到一个独立的页面,从而实现数据的抓取。

sina有相应的api,而app本身不实现,可以想办法用sinaapi抓取手机的内容。 查看全部

网站内容抓取到达后台页面,页面的内容需要用吗?

网站内容抓取到达后台页面,页面的内容需要用html5,然后在前端转换成纯javascript格式的javascript文件,

两个东西都不是问题,反正把后台数据结构做成json格式一样可以抓包。但你在asp上直接做这个肯定是不行的,首先asp虽然有调用系统的mfc等框架写接口但是好像接口体积都蛮大,还有就是不如开发一个servlet,或者webapp就直接把数据传过去了(当然asp做出来肯定要不像app那么精简)。如果你是给厂商给个psd文件供开发人员用那你觉得可以,或者你要给机器自己做就没法搞了。

有jsp的asp,

sina有w3capi,做个app你可以到,

根据你的app内容需求来定吧。一般程序员接触最多的无非页面的展示抓取,内容抓取和页面的抓取,无论这几种都是比较简单的应用。一般而言最简单的方法就是直接使用开发机制下的api。当然在app中,最基本的有一个android类似的东西来做页面的跳转,把用户可看到的内容跳转到一个独立的页面,从而实现数据的抓取。

sina有相应的api,而app本身不实现,可以想办法用sinaapi抓取手机的内容。

运营一个网站要如何吸引蜘蛛来抓取?(图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 112 次浏览 • 2021-06-25 22:15

导言:客户经常来问营销网站建公司的编辑为什么我们的网站内容不是收录,谁都知道好的网站每天都会有蜘蛛过来抓的对,那么只有蜘蛛来抢网站的内容才会是收录,收录量上去了网站排名和权重会上升,那么怎么跑一个网站来吸引蜘蛛呢?爬行?

营销类型网站construction如何吸引蜘蛛去抢网站content

第一,网站每天更新吗?

页面更新的频率会直接影响蜘蛛的访问频率。蜘蛛每次访问服务器时都会保存获取的页面数据。如果下次页面内容与存储的数据相同,蜘蛛就会认为页面不会频繁更新。 ,然后给网站一个优先权,决定以后访问的时间和频率。

如果营销网站内容更新频繁,而蜘蛛每次抓取的内容都不一样,蜘蛛会更频繁地访问此类页面,页面上出现的新链接自然会被抓取收录。

其次,原创content

蜘蛛最厉害的地方在于,它们会将网站新发布的内容与服务器收录的数据进行对比。如果抄袭或部分修改非原创伪原创内容,百度不会收录,如果经常发布非原创内容,也会降低蜘蛛访问频率,严重不会收录 ,甚至 0收录。

三、网站内链和外链的构建

引导链接的建立,无论网站的外链还是内链,想要被蜘蛛抓取,必须要有引导链接才能进入页面,所以合理构建内链非常重要,否则蜘蛛将无法发现页面的存在。导入高质量的外链也很重要,会增加蜘蛛跟踪爬行的深度。

四、网站重重的水平

网站和页面的权重仍然作为衡量网站价值的重要标准。优质老手网站被百度评为高权重。这种网站页面被蜘蛛爬取的概率比较高,所以很多内部页面都会被收录。 查看全部

运营一个网站要如何吸引蜘蛛来抓取?(图)

导言:客户经常来问营销网站建公司的编辑为什么我们的网站内容不是收录,谁都知道好的网站每天都会有蜘蛛过来抓的对,那么只有蜘蛛来抢网站的内容才会是收录,收录量上去了网站排名和权重会上升,那么怎么跑一个网站来吸引蜘蛛呢?爬行?

营销类型网站construction如何吸引蜘蛛去抢网站content

第一,网站每天更新吗?

页面更新的频率会直接影响蜘蛛的访问频率。蜘蛛每次访问服务器时都会保存获取的页面数据。如果下次页面内容与存储的数据相同,蜘蛛就会认为页面不会频繁更新。 ,然后给网站一个优先权,决定以后访问的时间和频率。

如果营销网站内容更新频繁,而蜘蛛每次抓取的内容都不一样,蜘蛛会更频繁地访问此类页面,页面上出现的新链接自然会被抓取收录。

其次,原创content

蜘蛛最厉害的地方在于,它们会将网站新发布的内容与服务器收录的数据进行对比。如果抄袭或部分修改非原创伪原创内容,百度不会收录,如果经常发布非原创内容,也会降低蜘蛛访问频率,严重不会收录 ,甚至 0收录。

三、网站内链和外链的构建

引导链接的建立,无论网站的外链还是内链,想要被蜘蛛抓取,必须要有引导链接才能进入页面,所以合理构建内链非常重要,否则蜘蛛将无法发现页面的存在。导入高质量的外链也很重要,会增加蜘蛛跟踪爬行的深度。

四、网站重重的水平

网站和页面的权重仍然作为衡量网站价值的重要标准。优质老手网站被百度评为高权重。这种网站页面被蜘蛛爬取的概率比较高,所以很多内部页面都会被收录。

怎么从网页抓取数据?利用完结小说免费下载全本软件

网站优化 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-06-25 22:09

如何从网页中获取数据?使用免费下载完整小说软件,可以一次免费阅读所有小说,现在推荐一款免费的完整txt小说电子书下载软件,使用网络图书抓取器,支持TXT全免费小说下载,用户可以使用网络小说抓取器,抓取网络小说,快速下载整本TXT电子书,最火的软件站提供了网络小说抓取器的下载地址,需要免费完整小说下载器的朋友,快来试试吧,体验简单易用的网页数据抓取工具,感受小说下载器的便捷功能。

网络图书抓取器简介

网页图书抓取器是一款网络小说下载软件,可以帮助用户在指定网页上下载某本书和某章节。软件功能强大,可以提取小说目录信息,根据目录下载小说,然后合并,下载后阅读方便,支持断点续传功能。如果网络问题或其他问题导致小说章节下载中断,可以点击继续下载,无需重新下载,然后继续下载上次下载的内容,下载完成后,您可以使用电脑小说阅读器阅读整部小说。

软件功能

1、章节调整:提取目录后,可以进行移动、删除、倒序等调整操作。调整会直接影响最终的书籍,也会以调整后的章节顺序输出。

2、Auto-retry:在爬取过程中,由于网络因素,可能会出现爬取失败的情况。程序可能会自动重试直到成功,也可以暂时中断爬取(中断后关闭程序不影响进度),待网络良好后再试。

3、Stop and resume:抓取过程可以随时停止,退出程序后不影响进度(章节信息会保存在记录中,运行后可以恢复抓取)下次程序。注意:需要先使用停止键中断然后退出程序,如果直接退出,将不会恢复)。

4、 一键抓图:又称“傻瓜模式”,基本可以实现全自动抓图合并功能,直接输出最终的文本文件。前面可能需要输入最基本的网址、保存位置等信息(会有明显的操作提示),调整章节后也可以一键抓取,抓取合并操作会自动完成.

5、Applicable网站:已经输入了10个适用的网站(选择后可以快速打开网站找到你需要的书),也可以自动申请相应的代码,或者申请到其他小说网站进行测试,如果一起使用,可以手动添加到配置文件中以备后用。

6、电子书制作方便:可以在设置文件中添加各章节名称的前缀和后缀,为后期制作电子书目录带来极大的方便。

软件功能

1、支持多种小说平台的小说爬取。

2、支持多种文字编码方式,避免文字乱码。

3、 一键提取查看小说所有目录。

4、支持调整小说章节位置,可上下移动。

5、支持在线查看章节内容,避免提取错误章节。

6、方支持抓取失败时手动或自动重新抓取。

7、抓取后的小说会以一章一文的形式保存。

8、 一键可以将所有章节合并为一个文本,方便保存。

软件优势

非常实用的网络小说抓取软件。有了它,用户可以快速提取网站十多部小说的章节和小说内容,并保存到本地。

这个爬虫工具功能齐全,非常友好。贴心为用户配备了4种文本编码器,防止用户在提取小说时出现乱码,并可一键提取提取的文件合并成一个文件

本软件使用方便,运行流畅,抓取错误率极低。如果您是小说爱好者,强烈建议您使用本软件进行小说抓取。

如何使用网络图书抓取器

1.下载软件后下载解压网络小说,双击使用,第一次运行会自动生成一个设置文件,用户可以手动调整文件,打开软件,使用软件的小说下载功能,

2. 首先进入要下载小说的网页,输入书名,点击目录提取,提取目录后可以移动、删除、倒序等调整操作,设置保存路径,点击开始爬取开始下载。

3.可以提取指定小说目录页的章节信息并进行调整,然后按照章节顺序抓取小说内容,然后合并。抓取过程可以随时中断,关闭程序后可以继续上一个任务。

4.在设置文件中添加了每个章节名称的前缀和后缀,给后期制作电子书的目录带来了极大的方便。已输入 10 个适用的 网站。选择后可以快速打开网站找到你需要的书,并自动应用相应的代码。

更新日志(2020.09.05)

可以提取指定小说目录页的章节信息并进行调整,然后按照章节顺序抓取小说内容,然后进行合并。

可以随时中断抓取过程,关闭程序后可以继续上一个任务。

小编推荐

以上是免费版在线图书抓取器的完整介绍。最流行的软件站点有更多类似的小说下载软件。有需要的朋友快来下载体验吧。下面推荐另外两个有用的。小说下载软件:网络抓取(网络抓取工具),微调小说下载器。 查看全部

怎么从网页抓取数据?利用完结小说免费下载全本软件

如何从网页中获取数据?使用免费下载完整小说软件,可以一次免费阅读所有小说,现在推荐一款免费的完整txt小说电子书下载软件,使用网络图书抓取器,支持TXT全免费小说下载,用户可以使用网络小说抓取器,抓取网络小说,快速下载整本TXT电子书,最火的软件站提供了网络小说抓取器的下载地址,需要免费完整小说下载器的朋友,快来试试吧,体验简单易用的网页数据抓取工具,感受小说下载器的便捷功能。

网络图书抓取器简介

网页图书抓取器是一款网络小说下载软件,可以帮助用户在指定网页上下载某本书和某章节。软件功能强大,可以提取小说目录信息,根据目录下载小说,然后合并,下载后阅读方便,支持断点续传功能。如果网络问题或其他问题导致小说章节下载中断,可以点击继续下载,无需重新下载,然后继续下载上次下载的内容,下载完成后,您可以使用电脑小说阅读器阅读整部小说。

软件功能

1、章节调整:提取目录后,可以进行移动、删除、倒序等调整操作。调整会直接影响最终的书籍,也会以调整后的章节顺序输出。

2、Auto-retry:在爬取过程中,由于网络因素,可能会出现爬取失败的情况。程序可能会自动重试直到成功,也可以暂时中断爬取(中断后关闭程序不影响进度),待网络良好后再试。

3、Stop and resume:抓取过程可以随时停止,退出程序后不影响进度(章节信息会保存在记录中,运行后可以恢复抓取)下次程序。注意:需要先使用停止键中断然后退出程序,如果直接退出,将不会恢复)。

4、 一键抓图:又称“傻瓜模式”,基本可以实现全自动抓图合并功能,直接输出最终的文本文件。前面可能需要输入最基本的网址、保存位置等信息(会有明显的操作提示),调整章节后也可以一键抓取,抓取合并操作会自动完成.

5、Applicable网站:已经输入了10个适用的网站(选择后可以快速打开网站找到你需要的书),也可以自动申请相应的代码,或者申请到其他小说网站进行测试,如果一起使用,可以手动添加到配置文件中以备后用。

6、电子书制作方便:可以在设置文件中添加各章节名称的前缀和后缀,为后期制作电子书目录带来极大的方便。

软件功能

1、支持多种小说平台的小说爬取。

2、支持多种文字编码方式,避免文字乱码。

3、 一键提取查看小说所有目录。

4、支持调整小说章节位置,可上下移动。

5、支持在线查看章节内容,避免提取错误章节。

6、方支持抓取失败时手动或自动重新抓取。

7、抓取后的小说会以一章一文的形式保存。

8、 一键可以将所有章节合并为一个文本,方便保存。

软件优势

非常实用的网络小说抓取软件。有了它,用户可以快速提取网站十多部小说的章节和小说内容,并保存到本地。

这个爬虫工具功能齐全,非常友好。贴心为用户配备了4种文本编码器,防止用户在提取小说时出现乱码,并可一键提取提取的文件合并成一个文件

本软件使用方便,运行流畅,抓取错误率极低。如果您是小说爱好者,强烈建议您使用本软件进行小说抓取。

如何使用网络图书抓取器

1.下载软件后下载解压网络小说,双击使用,第一次运行会自动生成一个设置文件,用户可以手动调整文件,打开软件,使用软件的小说下载功能,

2. 首先进入要下载小说的网页,输入书名,点击目录提取,提取目录后可以移动、删除、倒序等调整操作,设置保存路径,点击开始爬取开始下载。

3.可以提取指定小说目录页的章节信息并进行调整,然后按照章节顺序抓取小说内容,然后合并。抓取过程可以随时中断,关闭程序后可以继续上一个任务。

4.在设置文件中添加了每个章节名称的前缀和后缀,给后期制作电子书的目录带来了极大的方便。已输入 10 个适用的 网站。选择后可以快速打开网站找到你需要的书,并自动应用相应的代码。

更新日志(2020.09.05)

可以提取指定小说目录页的章节信息并进行调整,然后按照章节顺序抓取小说内容,然后进行合并。

可以随时中断抓取过程,关闭程序后可以继续上一个任务。

小编推荐

以上是免费版在线图书抓取器的完整介绍。最流行的软件站点有更多类似的小说下载软件。有需要的朋友快来下载体验吧。下面推荐另外两个有用的。小说下载软件:网络抓取(网络抓取工具),微调小说下载器。

Excel教程Excel函数Excel表格制作Excel2010电子表格Excel实用技巧

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-06-24 23:20

组织一些最近的项目。总结几个用到的知识点和代码的关键部分,供大家学习交流。

1、crawler 抓取网页内容信息。可以通过System.Net.WebRequest、webclient等类来处理

2、对于一些动态网页,链接信息是由javascript动态生成的。也可以分析传值方式,把参数带入帖子中(大部分网站参数被统治)。如果还是不行,还可以使用webbrowser控件模拟点击。或者按值传递。

以网站 为例。

部分代码如下:

//使用网页浏览器访问指定网页。地址是网址

private void Navigate(WebBrowser web,String address)

{

if (String.IsNullOrEmpty(address)) return;

if (address.Equals("about:blank")) return;

if (!address.StartsWith("http://")) address = "http://" + address;

试试

{

web.Navigate(new Uri(address));

}

catch (System.UriFormatException)

{

返回;

}

}

因为要抓取网页内容,加载后提交参数,所以需要验证加载完成,即DocumentCompleted。在实际使用过程中,发现一个页面的加载过程中可能有多个DocumentCompleted,所以这里使用+1、-1方法来判断是否加载完成。

首先在formload中绑定网页加载完成事件。

private void getCode3webBrowser_Load(object sender, EventArgs e)

{

string address = "http://www.aslan.com.cn/Code.aspx";

this.Navigate(webBrowser1, address);

webBrowser1.Navigated += new WebBrowserNavigatedEventHandler(webBrowser_Navigated);

webBrowser1.DocumentCompleted += new WebBrowserDocumentCompletedEventHandler(webBrowser_DocumentCompleted);

}

并定义标记计数

int count = 0;

然后在每次导航后给标记+1

private void webBrowser_Navigated(object sender, WebBrowserNavigatedEventArgs e)

{

count++;

}

在每个 DocumentCompleted 中,都给出了 count-1。最后,当count=0时,表示页面加载完毕。可以进行页面信息处理等操作。

<p> <p> private void webBrowser_DocumentCompleted(object sender, WebBrowserDocumentCompletedEventArgs e)

{

count = count - 1;

string eventTarget = "dg_Code$ctl24$ctl";

if (0 == count && isComplete == false && j 查看全部

Excel教程Excel函数Excel表格制作Excel2010电子表格Excel实用技巧

组织一些最近的项目。总结几个用到的知识点和代码的关键部分,供大家学习交流。

1、crawler 抓取网页内容信息。可以通过System.Net.WebRequest、webclient等类来处理

2、对于一些动态网页,链接信息是由javascript动态生成的。也可以分析传值方式,把参数带入帖子中(大部分网站参数被统治)。如果还是不行,还可以使用webbrowser控件模拟点击。或者按值传递。

以网站 为例。

部分代码如下:

//使用网页浏览器访问指定网页。地址是网址

private void Navigate(WebBrowser web,String address)

{

if (String.IsNullOrEmpty(address)) return;

if (address.Equals("about:blank")) return;

if (!address.StartsWith("http://";)) address = "http://" + address;

试试

{

web.Navigate(new Uri(address));

}

catch (System.UriFormatException)

{

返回;

}

}

因为要抓取网页内容,加载后提交参数,所以需要验证加载完成,即DocumentCompleted。在实际使用过程中,发现一个页面的加载过程中可能有多个DocumentCompleted,所以这里使用+1、-1方法来判断是否加载完成。

首先在formload中绑定网页加载完成事件。

private void getCode3webBrowser_Load(object sender, EventArgs e)

{

string address = "http://www.aslan.com.cn/Code.aspx";

this.Navigate(webBrowser1, address);

webBrowser1.Navigated += new WebBrowserNavigatedEventHandler(webBrowser_Navigated);

webBrowser1.DocumentCompleted += new WebBrowserDocumentCompletedEventHandler(webBrowser_DocumentCompleted);

}

并定义标记计数

int count = 0;

然后在每次导航后给标记+1

private void webBrowser_Navigated(object sender, WebBrowserNavigatedEventArgs e)

{

count++;

}

在每个 DocumentCompleted 中,都给出了 count-1。最后,当count=0时,表示页面加载完毕。可以进行页面信息处理等操作。

<p> <p> private void webBrowser_DocumentCompleted(object sender, WebBrowserDocumentCompletedEventArgs e)

{

count = count - 1;

string eventTarget = "dg_Code$ctl24$ctl";

if (0 == count && isComplete == false && j

网页单单用正则表达式并不能完成抓取抓取工作

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-06-24 23:19

作者:finallyliuyu(转载请注明作者:finallyliuyu,来源:博客园)我从申请过程开始就从事网络数据采集采集一年多,开始主要针对静态网页,编写正则表达式,从网上抓取信息。但是随着工作的深入,发现很多网页无法单独使用正则表达式进行爬取。比如很多网页的下一页链接都是由JavaScript函数生成的,比如

C#实现网页信息自动爬取

05-03

1144

NetBug--Crawler V1.02 开发笔记 背景 随着互联网的普及,网络信息以极高的速度增长。在如此多的数据中找到您需要的信息是一项非常繁琐的任务。 Find 如何获取所需的信息也是一件麻烦事。这就需要互联网信息抓取程序来代替人工操作。所谓互联网信息采集程序,就是程序会根据用户的关键词或密钥网站采集相应的信息,并提供给用户所需的信息格式。信息量的增加会带来信息网站release

CSDN开发者助手,常用网站自动集成,一键调用多种工具

CSDN开发助手由CSDN官方开发,集成了四大功能:一键出站搜索、通用快捷工具、个性化新标签页、官方无广告。助您开发效率提升10倍!

指针是C语言的精髓-4.3.C语言专题第3部分

09-15

本课程的主要内容是指针。 10节课,五六个小时,从10个角度讲解指针的用法和相关知识点。其中很多是C程序员难以理解或应用到实际编程中的知识点,也是嵌入式程序员在笔试中经常遇到的问题。本课程的目标是让大家深入了解各种指点。 查看全部

网页单单用正则表达式并不能完成抓取抓取工作

作者:finallyliuyu(转载请注明作者:finallyliuyu,来源:博客园)我从申请过程开始就从事网络数据采集采集一年多,开始主要针对静态网页,编写正则表达式,从网上抓取信息。但是随着工作的深入,发现很多网页无法单独使用正则表达式进行爬取。比如很多网页的下一页链接都是由JavaScript函数生成的,比如

C#实现网页信息自动爬取

05-03

1144

NetBug--Crawler V1.02 开发笔记 背景 随着互联网的普及,网络信息以极高的速度增长。在如此多的数据中找到您需要的信息是一项非常繁琐的任务。 Find 如何获取所需的信息也是一件麻烦事。这就需要互联网信息抓取程序来代替人工操作。所谓互联网信息采集程序,就是程序会根据用户的关键词或密钥网站采集相应的信息,并提供给用户所需的信息格式。信息量的增加会带来信息网站release

CSDN开发者助手,常用网站自动集成,一键调用多种工具

CSDN开发助手由CSDN官方开发,集成了四大功能:一键出站搜索、通用快捷工具、个性化新标签页、官方无广告。助您开发效率提升10倍!

指针是C语言的精髓-4.3.C语言专题第3部分

09-15

本课程的主要内容是指针。 10节课,五六个小时,从10个角度讲解指针的用法和相关知识点。其中很多是C程序员难以理解或应用到实际编程中的知识点,也是嵌入式程序员在笔试中经常遇到的问题。本课程的目标是让大家深入了解各种指点。

网页数据抓取哪种方法最快?(要最详细的)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2021-06-22 18:40

哪种方法获取网络数据最快? (最详细)

网络获取数据的方式有哪些?

主要是ajax获取数据,当然也可以通过websocket获取数据。其中,ajax是最主要的获取数据的方式。界面写在后台,前端发CSS布局HTML编辑器,今天分享给大家,获取后台返回的数据,然后通过js解析,渲染到页面上。 Websocket 也可以获取数据。

如何从网站或者软件中抓取数据网站是BS架构,软件是CS架构。目前爬虫工具和软件机器人工具可以抓取网站数据。在软件中,爬虫暂时无法实现。软件机器人工具可以抓取它。抓取的是界面上的数据。界面上看不见的东西采集做不到。

用php就可以完成,但是需要很多代码。说实话,我没有写那么多代码的动力……可能流程是先获取你发送的URL中收录的URL,然后循环,再抓取里面的URL。回收和获取内容很简单。

WebClient MyWebClient = new WebClient(); MyWebClient.Credentials = CredentialCache.DefaultCredentials; //获取或设置Internet资源的CSS布局HTML编辑器,今天与大家分享认证的网络凭据Byte[] pageData = MyWebClient.DownloadData(tbUrl.Text); //从指定

有什么好的方法可以更好的获取网页上的表格数据吗?

可以通过Excel的外部数据获取功能来实现,具体操作如下:

选择你想要获取数据的网站(不是所有网站都能获取到你想要的数据),复制完整的网站。地址已保留。

打开 Excel,单击“数据”选项卡,然后选择“获取外部数据 - 从网站”按钮。

应该使用什么方法从 Excel 等网页中获取数据? Excel“数据”选项中,有“获取外部数据”和“来自网站”,按照相应的步骤“导入”即可。

如何获取网页上的数据

编辑软件获取网页上的数据,分几步写软件和哪方面的知识,有没有这一面的图片上传,如果不上传图片,路径是你本地的路径,要在网上使用,必须先上传。替换所有本地路径后,如果不知道如何在DW中查看源文件(即HTML),可以先按F12预览,然后在网页上点击【反键-】。 》查看源文件]就OK了

什么是网页数据抓取?它是获取网页的一些数据,一些是获取有关网页内容的一些信息,还有一些是获取有关您浏览的一些信息。事件信息、点击信息等 查看全部

网页数据抓取哪种方法最快?(要最详细的)

哪种方法获取网络数据最快? (最详细)

网络获取数据的方式有哪些?

主要是ajax获取数据,当然也可以通过websocket获取数据。其中,ajax是最主要的获取数据的方式。界面写在后台,前端发CSS布局HTML编辑器,今天分享给大家,获取后台返回的数据,然后通过js解析,渲染到页面上。 Websocket 也可以获取数据。

如何从网站或者软件中抓取数据网站是BS架构,软件是CS架构。目前爬虫工具和软件机器人工具可以抓取网站数据。在软件中,爬虫暂时无法实现。软件机器人工具可以抓取它。抓取的是界面上的数据。界面上看不见的东西采集做不到。

用php就可以完成,但是需要很多代码。说实话,我没有写那么多代码的动力……可能流程是先获取你发送的URL中收录的URL,然后循环,再抓取里面的URL。回收和获取内容很简单。

WebClient MyWebClient = new WebClient(); MyWebClient.Credentials = CredentialCache.DefaultCredentials; //获取或设置Internet资源的CSS布局HTML编辑器,今天与大家分享认证的网络凭据Byte[] pageData = MyWebClient.DownloadData(tbUrl.Text); //从指定

有什么好的方法可以更好的获取网页上的表格数据吗?

可以通过Excel的外部数据获取功能来实现,具体操作如下:

选择你想要获取数据的网站(不是所有网站都能获取到你想要的数据),复制完整的网站。地址已保留。

打开 Excel,单击“数据”选项卡,然后选择“获取外部数据 - 从网站”按钮。

应该使用什么方法从 Excel 等网页中获取数据? Excel“数据”选项中,有“获取外部数据”和“来自网站”,按照相应的步骤“导入”即可。

如何获取网页上的数据

编辑软件获取网页上的数据,分几步写软件和哪方面的知识,有没有这一面的图片上传,如果不上传图片,路径是你本地的路径,要在网上使用,必须先上传。替换所有本地路径后,如果不知道如何在DW中查看源文件(即HTML),可以先按F12预览,然后在网页上点击【反键-】。 》查看源文件]就OK了

什么是网页数据抓取?它是获取网页的一些数据,一些是获取有关网页内容的一些信息,还有一些是获取有关您浏览的一些信息。事件信息、点击信息等

用wireshark网站抓取网站登录弱口令(**步)

网站优化 • 优采云 发表了文章 • 0 个评论 • 110 次浏览 • 2021-06-22 18:34

Wireshark 本身无法破解弱密码,但我们可以通过分析捕获的数据手动破解。

今天我将使用Smart Testing博客和FTP来做实验(账号和密码都是新的,没有权限,所以请不要用这个)。

一:使用wireshark抓取网站login弱密码

1、 ***这一步我们设置抓包过滤器(这次我们抓的是http数据包,你只需要在抓包过滤器里输入http即可)

2、点击开始后,打开我的博客地址()点击登录,来到页面,输入用户名和密码,然后点击登录。

3、 登录后就可以结束wireshark的抓包过程了。

4、 然后我们设置显示过滤器:使用ip.addr == 203.171.239.103 这是我博客服务器的IP地址,可以减少很多http数据. (可以在cmd下使用ping命令获取你的网站ip地址)

Wireshark 显示过滤器

5、过滤后,我们搜索带有/wp-login.php这个词的数据(wp-login.php是我博客的后台登录页面地址)。

6、 查看/wp-login.php 的所有数据。事实上,总共有2个。我们在第二个数据中捕获了 (log=huaisha&pwd=279478776&wp-submit=)。这是我的账号和密码(用户:huaisha/pwd:279478776)

当然,如果用户的密码比较复杂,这样获取密码基本上是错误的,所以只能获取弱密码。

wireshark 捕获的账号密码

二:使用wireshark抓取FTP账号和密码

和上面一样,我们会抓取FTP账号和密码。抓取FTP账号和密码时,不是针对弱密码的。只要能抓取到FTP数据,就可以得到FTP账号和密码。密码。

操作

1、 设置抓包过滤器只抓ftp包

2、打开ftp工具登录你的FTP服务器

3、 然后结束抓包过程

4、正在设置显示过滤器(ip.addr == 192.168.9.1 你的FTP地址)

5、然后我们会发现FTP账号和密码都是明文显示的,好酷。

[编辑推荐]

使用Lua编写Wireshark的Dissector插件Wireshark表达式使用技巧-IP过滤Wireshark增加了使用WireShark捕获分析数据包的基本RDP解析器方法教你如何使用Wireshark监控无线网络 查看全部

用wireshark网站抓取网站登录弱口令(**步)

Wireshark 本身无法破解弱密码,但我们可以通过分析捕获的数据手动破解。

今天我将使用Smart Testing博客和FTP来做实验(账号和密码都是新的,没有权限,所以请不要用这个)。

一:使用wireshark抓取网站login弱密码

1、 ***这一步我们设置抓包过滤器(这次我们抓的是http数据包,你只需要在抓包过滤器里输入http即可)

2、点击开始后,打开我的博客地址()点击登录,来到页面,输入用户名和密码,然后点击登录。

3、 登录后就可以结束wireshark的抓包过程了。

4、 然后我们设置显示过滤器:使用ip.addr == 203.171.239.103 这是我博客服务器的IP地址,可以减少很多http数据. (可以在cmd下使用ping命令获取你的网站ip地址)

Wireshark 显示过滤器

5、过滤后,我们搜索带有/wp-login.php这个词的数据(wp-login.php是我博客的后台登录页面地址)。

6、 查看/wp-login.php 的所有数据。事实上,总共有2个。我们在第二个数据中捕获了 (log=huaisha&pwd=279478776&wp-submit=)。这是我的账号和密码(用户:huaisha/pwd:279478776)

当然,如果用户的密码比较复杂,这样获取密码基本上是错误的,所以只能获取弱密码。

wireshark 捕获的账号密码

二:使用wireshark抓取FTP账号和密码

和上面一样,我们会抓取FTP账号和密码。抓取FTP账号和密码时,不是针对弱密码的。只要能抓取到FTP数据,就可以得到FTP账号和密码。密码。

操作

1、 设置抓包过滤器只抓ftp包

2、打开ftp工具登录你的FTP服务器

3、 然后结束抓包过程

4、正在设置显示过滤器(ip.addr == 192.168.9.1 你的FTP地址)

5、然后我们会发现FTP账号和密码都是明文显示的,好酷。

[编辑推荐]

使用Lua编写Wireshark的Dissector插件Wireshark表达式使用技巧-IP过滤Wireshark增加了使用WireShark捕获分析数据包的基本RDP解析器方法教你如何使用Wireshark监控无线网络

SEO优化网站内容要想被搜索引擎蜘蛛爬行和抓取到

网站优化 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-06-18 23:17

云雅SEO

专注于网站SEO优化

网站内容要被搜索引擎收录搜索到,首先它的内容必须被搜索引擎蜘蛛抓取和抓取。如果网站程序设计有蜘蛛爬虫陷阱,对搜索引擎非常不友好,会导致网站内容无法被搜索引擎收录搜索到。这些不利于搜索引擎蜘蛛爬行和爬行的技术将被定义为蜘蛛陷阱。主要有七种:FLASH、Session、各种跳转、各种框架结构、动态网址、JavaScript链接、强制使用Cookies

1、FLASH

在 H5 流行之前,Flash 因其强大的视觉体验被很多程序员在网页设计中使用。但是网站大量使用Flash对搜索引擎非常不友好,有的网站甚至将整个主页作为一个FLASH文件,这显然构成了蜘蛛陷阱,因为蜘蛛抓取的只是一个FLASH文件链接FLASH 文件,并且没有其他可读的文本内容。也使得算法程序无法计算网站的相关性。

2、会话 ID

随着网站程序变得越来越复杂,很多网站使用应答ID来跟踪用户的访问。每当用户访问网站 时,网站 程序都会创建一个带有动态 ID 的页面 URL。这样,搜索引擎蜘蛛每次访问时都会得到同一页面的多个 URL。这也是当今网站程序设计中常见的蜘蛛陷阱之一。因此,建议使用 cookie 来跟踪用户访问,而不是选择 Session ID。

3、各种跳跃

除301跳转外,搜索引擎对其他跳转方式更为敏感。建议谨慎使用,如JavaScript跳转、Flash跳转、Meta Refresh跳转等。

4、各种框架结构

作为程序员,我熟悉框架结构(Frame),但框架结构也会对蜘蛛造成致命伤害。由于框架结构非常方便网站页面的维护和更新,之前在web编程中被广泛使用,但现在很少有程序员使用框架结构。更重要的原因之一是框架结构不利于搜索引擎抓取。

5、动态网址

定义:动态网址是指动态数据库驱动生成的带有问号、等号或其他参数的网址链接。随着搜索引擎的技术变革,动态网址抓取不再是搜索引擎的大问题,但动态网址仍然不利于抓取和抓取到搜索引擎,也不利于用户体验。

6、JavaScript 链接

因为JavaScript优秀的动画制作在网站设计的导航等栏目中被广泛引用,这对搜索引擎也是非常不友好的,虽然目前的搜索引擎在技术上已经能够实现JavaScript脚本了,但是在鉴于网络资源的珍贵,搜索引擎不会在你的网站上花大价钱,所以我们要迎合搜索引擎的喜好,而不是去激发搜索引擎的潜力。所以网站导航链接最好使用HTML链接。当然,CSS对于导航也能有很好的视觉体验。

7、强制使用cookies

有些网站为了实现某些功能而强制用户使用Cookies,但对于搜索引擎来说,它就像禁用了Cookies的浏览器。结果只能导致搜索引擎蜘蛛无法正常访问网站。

查看全部

SEO优化网站内容要想被搜索引擎蜘蛛爬行和抓取到

云雅SEO

专注于网站SEO优化

网站内容要被搜索引擎收录搜索到,首先它的内容必须被搜索引擎蜘蛛抓取和抓取。如果网站程序设计有蜘蛛爬虫陷阱,对搜索引擎非常不友好,会导致网站内容无法被搜索引擎收录搜索到。这些不利于搜索引擎蜘蛛爬行和爬行的技术将被定义为蜘蛛陷阱。主要有七种:FLASH、Session、各种跳转、各种框架结构、动态网址、JavaScript链接、强制使用Cookies

1、FLASH

在 H5 流行之前,Flash 因其强大的视觉体验被很多程序员在网页设计中使用。但是网站大量使用Flash对搜索引擎非常不友好,有的网站甚至将整个主页作为一个FLASH文件,这显然构成了蜘蛛陷阱,因为蜘蛛抓取的只是一个FLASH文件链接FLASH 文件,并且没有其他可读的文本内容。也使得算法程序无法计算网站的相关性。

2、会话 ID

随着网站程序变得越来越复杂,很多网站使用应答ID来跟踪用户的访问。每当用户访问网站 时,网站 程序都会创建一个带有动态 ID 的页面 URL。这样,搜索引擎蜘蛛每次访问时都会得到同一页面的多个 URL。这也是当今网站程序设计中常见的蜘蛛陷阱之一。因此,建议使用 cookie 来跟踪用户访问,而不是选择 Session ID。

3、各种跳跃

除301跳转外,搜索引擎对其他跳转方式更为敏感。建议谨慎使用,如JavaScript跳转、Flash跳转、Meta Refresh跳转等。

4、各种框架结构

作为程序员,我熟悉框架结构(Frame),但框架结构也会对蜘蛛造成致命伤害。由于框架结构非常方便网站页面的维护和更新,之前在web编程中被广泛使用,但现在很少有程序员使用框架结构。更重要的原因之一是框架结构不利于搜索引擎抓取。

5、动态网址

定义:动态网址是指动态数据库驱动生成的带有问号、等号或其他参数的网址链接。随着搜索引擎的技术变革,动态网址抓取不再是搜索引擎的大问题,但动态网址仍然不利于抓取和抓取到搜索引擎,也不利于用户体验。

6、JavaScript 链接

因为JavaScript优秀的动画制作在网站设计的导航等栏目中被广泛引用,这对搜索引擎也是非常不友好的,虽然目前的搜索引擎在技术上已经能够实现JavaScript脚本了,但是在鉴于网络资源的珍贵,搜索引擎不会在你的网站上花大价钱,所以我们要迎合搜索引擎的喜好,而不是去激发搜索引擎的潜力。所以网站导航链接最好使用HTML链接。当然,CSS对于导航也能有很好的视觉体验。

7、强制使用cookies

有些网站为了实现某些功能而强制用户使用Cookies,但对于搜索引擎来说,它就像禁用了Cookies的浏览器。结果只能导致搜索引擎蜘蛛无法正常访问网站。

网站抓取建设指南、网站数据生产指南和死链处理指南

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-06-18 21:09

在网站的实际操作中,很多站长对百度的一些处理机制还是很迷茫的。例如:

……

如果你也对这些问题感到困惑,那么你应该阅读这个文章!

近日,百度搜索研发工程师在百度搜索在线公开课与大家分享了网站Grab建设指南、网站数据生产指南和网站死链处理指南,并进行了答疑解惑。很多站长都有疑惑。

以下是百度搜索在线公共课程中的一些重要答案:

网站Grab 施工指南

Q1:百度搜索会给新网站更高的抓取频率吗?

A1:百度搜索会首先识别网站内容的质量。优质内容的新网站会在抓取频率上有一定的倾斜,以帮助内容更好地展示。

Q2:如何让百度搜索知道我的网站是新站?

A2:主要有两种方式:1、通过百度搜索资源平台-资源提交工具提交内容; 2、网站工信部备案。

Q3:百度搜索会不会调整网站爬取的频率?

A3:是的。百度搜索会根据网站内容质量、内容更新频率、网站尺度变化等维度进行综合计算。如果内容质量或内容更新频率下降,百度搜索可能会减少对网站频率的抓取。

不过,爬取频率不一定与收录量有关。比如降低历史资源的爬取频率不会影响新资源的收录效果。

Q4:为什么百度的PC蜘蛛抓取移动页面?

A4:百度搜索会尽量使用移动端UA抓取移动端页面,但是当蜘蛛不能准确判断是PC端还是移动端页面时,会使用PC端UA进行抓取。无论哪种方式,只要能正常抓取网站页面,都不会影响网站内容的收录。

网站数据制作指南

Q5:网站上线前需要发布多少条内容?是应该尽可能多,还是创造高质量的内容,小而精?

A5:百度搜索主张开发者制作能够满足用户需求的优质内容,注重内容的质量而不是数量。如果内容是优质的,即使网站的内容不多,依然会受到百度搜索的青睐。

Q6:我还可以修改已经收录的页面内容吗?会不会影响百度搜索对该页面的评价?

A6:如果内容确实需要修改,并且修改后的内容仍然是高质量的,不会影响百度搜索对该页面的评价。

网站死链接处理指南

Q7:发表的文章质量不高。如果要修改,需要将原内容设置为死链接,重新发布一个文章?

A7:如果修改的内容与原内容高度相关,可以在原内容的基础上直接修改,无需提交死链接;如果修改后的内容与原内容相关度较低,建议将原内容设置为Dead link,新制作的内容通过资源提交工具提交。

Q8:网站中有大量死链接。通过死链工具提交死链后,百度搜索对网站的评价会降低吗?

A8: 不会。如果网站存在大量死链接,但没有提交死链接,会影响百度搜索对网站的评价。

Q9:网站被黑后,产生了大量的随机链接。被机器人阻止时链接是否应该区分大小写?

A9:需要区分大小写。建议网站被黑后,将随机链接设置为死链接,通过死链接工具提交,同步设置Robots区块。

相关阅读:如何快速获取单页百度排名百度百家号2019Q3内容治理报告:4万多封禁账号下线文章超56万篇百度BFE转发引擎开源!一个类似于Nginx的七层流量转发平台谨慎注册百度百家号。百度推出“一键查询医用口罩厂家”功能。百度移动开放平台关闭91个无线和安卓市场渠道 查看全部

网站抓取建设指南、网站数据生产指南和死链处理指南

在网站的实际操作中,很多站长对百度的一些处理机制还是很迷茫的。例如:

……

如果你也对这些问题感到困惑,那么你应该阅读这个文章!

近日,百度搜索研发工程师在百度搜索在线公开课与大家分享了网站Grab建设指南、网站数据生产指南和网站死链处理指南,并进行了答疑解惑。很多站长都有疑惑。

以下是百度搜索在线公共课程中的一些重要答案:

网站Grab 施工指南

Q1:百度搜索会给新网站更高的抓取频率吗?

A1:百度搜索会首先识别网站内容的质量。优质内容的新网站会在抓取频率上有一定的倾斜,以帮助内容更好地展示。

Q2:如何让百度搜索知道我的网站是新站?

A2:主要有两种方式:1、通过百度搜索资源平台-资源提交工具提交内容; 2、网站工信部备案。

Q3:百度搜索会不会调整网站爬取的频率?

A3:是的。百度搜索会根据网站内容质量、内容更新频率、网站尺度变化等维度进行综合计算。如果内容质量或内容更新频率下降,百度搜索可能会减少对网站频率的抓取。

不过,爬取频率不一定与收录量有关。比如降低历史资源的爬取频率不会影响新资源的收录效果。

Q4:为什么百度的PC蜘蛛抓取移动页面?

A4:百度搜索会尽量使用移动端UA抓取移动端页面,但是当蜘蛛不能准确判断是PC端还是移动端页面时,会使用PC端UA进行抓取。无论哪种方式,只要能正常抓取网站页面,都不会影响网站内容的收录。

网站数据制作指南

Q5:网站上线前需要发布多少条内容?是应该尽可能多,还是创造高质量的内容,小而精?

A5:百度搜索主张开发者制作能够满足用户需求的优质内容,注重内容的质量而不是数量。如果内容是优质的,即使网站的内容不多,依然会受到百度搜索的青睐。

Q6:我还可以修改已经收录的页面内容吗?会不会影响百度搜索对该页面的评价?

A6:如果内容确实需要修改,并且修改后的内容仍然是高质量的,不会影响百度搜索对该页面的评价。

网站死链接处理指南

Q7:发表的文章质量不高。如果要修改,需要将原内容设置为死链接,重新发布一个文章?

A7:如果修改的内容与原内容高度相关,可以在原内容的基础上直接修改,无需提交死链接;如果修改后的内容与原内容相关度较低,建议将原内容设置为Dead link,新制作的内容通过资源提交工具提交。

Q8:网站中有大量死链接。通过死链工具提交死链后,百度搜索对网站的评价会降低吗?

A8: 不会。如果网站存在大量死链接,但没有提交死链接,会影响百度搜索对网站的评价。

Q9:网站被黑后,产生了大量的随机链接。被机器人阻止时链接是否应该区分大小写?

A9:需要区分大小写。建议网站被黑后,将随机链接设置为死链接,通过死链接工具提交,同步设置Robots区块。

相关阅读:如何快速获取单页百度排名百度百家号2019Q3内容治理报告:4万多封禁账号下线文章超56万篇百度BFE转发引擎开源!一个类似于Nginx的七层流量转发平台谨慎注册百度百家号。百度推出“一键查询医用口罩厂家”功能。百度移动开放平台关闭91个无线和安卓市场渠道

搜索引擎进行网站内容的抓取时究竟有什么技巧?

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-06-18 06:09

我们在运营网站的时候,都希望我们的网站内容能被收录快速抓取,但是搜索引擎对于网站内容和网页抓取收录是一个复杂的过程,简单的在也就是说收录的过程可以分为:爬取、过滤、索引、输出结果。尤其是现在随着搜索引擎的不断升级,比如百度搜索引擎的毛毛雨算法横空出世,肯定会对网站收录抢夺产生影响。那么,搜索引擎爬取网站内容有哪些技巧呢?今天青岛网站给大家分享一下网站运营中影响网页收录爬取的因素有哪些?希望能帮到你。

第一:网站speed Impact网站取取收录

<p>网站能否正常访问是搜索引擎的连通程度。连接要求网站不能频繁访问,或者访问速度极慢。机房问题、dns问题、CDN加速问题、服务器带宽、服务器硬件、操作系统、服务器软件、服务器安装的程序等可能会影响我们网站的打开速度和网站的正常访问。 查看全部

搜索引擎进行网站内容的抓取时究竟有什么技巧?

我们在运营网站的时候,都希望我们的网站内容能被收录快速抓取,但是搜索引擎对于网站内容和网页抓取收录是一个复杂的过程,简单的在也就是说收录的过程可以分为:爬取、过滤、索引、输出结果。尤其是现在随着搜索引擎的不断升级,比如百度搜索引擎的毛毛雨算法横空出世,肯定会对网站收录抢夺产生影响。那么,搜索引擎爬取网站内容有哪些技巧呢?今天青岛网站给大家分享一下网站运营中影响网页收录爬取的因素有哪些?希望能帮到你。

第一:网站speed Impact网站取取收录

<p>网站能否正常访问是搜索引擎的连通程度。连接要求网站不能频繁访问,或者访问速度极慢。机房问题、dns问题、CDN加速问题、服务器带宽、服务器硬件、操作系统、服务器软件、服务器安装的程序等可能会影响我们网站的打开速度和网站的正常访问。

百度蜘蛛是什么样的抓取频次过大怎么办

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-06-18 06:05

抓取频率是百度搜索引擎下的百度蜘蛛程序。用于每天抓取网站的优质页面和内容、图片等,让用户在搜索引擎中快速找到你网站的内容,那么百度蜘蛛是如何抓取的,以及什么频率爬行,我们接下来了解一下。

什么是抓取频率

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎抓取网站过于频繁,可能会造成服务器不稳定,百度蜘蛛会根据网站内容更新频率、服务器压力等因素自动调整抓取频率。

什么情况下可以抓取频次上限调整?

首先,百度蜘蛛会根据网站server压力自动调整爬取频率。其次,如果Baiduspider的爬行影响了网站的稳定性,站长可以使用这个工具来调整Baiduspider每天爬取你的网站的频率限制。

重点1:调整爬取频率上限并不意味着增加爬取频率。重点2:建议您仔细调整爬取频率的上限。抓取频率太小,会影响百度蜘蛛的网站的收录。

当前抓取频率过高怎么办?

您可以按照以下顺序排查频率过高的问题:

1、如果您认为Baiduspider抓取了您认为无价值的链接,请更新网站robots.txt以阻止抓取,然后进入robots工具页面生效。

2、如果百度蜘蛛的抓取影响了您网站的正常访问,请到抓取频次上限调整页面调低抓取频次上限。

3、以上方法均不能解决问题,请到百度站长平台反馈中心反馈。

当前抓取频率太小怎么办?

您可以按照以下方法排查和解决低频问题:

1、如果您设置了抓取频次上限,建议您先取消抓取频次上限设置,或者到抓取频次上限调整页面调整抓取频次上限。

2、如果您还没有设置抓取频次上限,建议使用抓取异常工具检查是否是抓取异常引起的。

3、如果还是觉得抓取量小,可能是你没有提交新链接。请到链接提交页面提交数据。

4、以上方法均不能解决问题,请到百度站长平台反馈中心反馈。 查看全部

百度蜘蛛是什么样的抓取频次过大怎么办

抓取频率是百度搜索引擎下的百度蜘蛛程序。用于每天抓取网站的优质页面和内容、图片等,让用户在搜索引擎中快速找到你网站的内容,那么百度蜘蛛是如何抓取的,以及什么频率爬行,我们接下来了解一下。

什么是抓取频率

爬取频率是搜索引擎在单位时间内(天级别)爬取网站服务器的总次数。如果搜索引擎抓取网站过于频繁,可能会造成服务器不稳定,百度蜘蛛会根据网站内容更新频率、服务器压力等因素自动调整抓取频率。

什么情况下可以抓取频次上限调整?

首先,百度蜘蛛会根据网站server压力自动调整爬取频率。其次,如果Baiduspider的爬行影响了网站的稳定性,站长可以使用这个工具来调整Baiduspider每天爬取你的网站的频率限制。

重点1:调整爬取频率上限并不意味着增加爬取频率。重点2:建议您仔细调整爬取频率的上限。抓取频率太小,会影响百度蜘蛛的网站的收录。

当前抓取频率过高怎么办?

您可以按照以下顺序排查频率过高的问题:

1、如果您认为Baiduspider抓取了您认为无价值的链接,请更新网站robots.txt以阻止抓取,然后进入robots工具页面生效。

2、如果百度蜘蛛的抓取影响了您网站的正常访问,请到抓取频次上限调整页面调低抓取频次上限。

3、以上方法均不能解决问题,请到百度站长平台反馈中心反馈。

当前抓取频率太小怎么办?

您可以按照以下方法排查和解决低频问题:

1、如果您设置了抓取频次上限,建议您先取消抓取频次上限设置,或者到抓取频次上限调整页面调整抓取频次上限。

2、如果您还没有设置抓取频次上限,建议使用抓取异常工具检查是否是抓取异常引起的。

3、如果还是觉得抓取量小,可能是你没有提交新链接。请到链接提交页面提交数据。

4、以上方法均不能解决问题,请到百度站长平台反馈中心反馈。

WebScraping支持以240多种语言提取Web数据提取工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2021-06-17 05:16

Web Scraping 工具专门用于从网站 中提取信息。它们也称为网络采集工具或网络数据提取工具。

Web Scraping 工具可以在各种场景中用于无限用途。

例如:

1.采集市场调研数据

网页抓取工具可以从多个数据分析提供商处获取信息,并将它们整合到一个位置,以便于参考和分析。可以帮助您及时了解公司或行业未来六个月的发展方向。

2.提取联系方式

这些工具还可用于从各种网站 中提取电子邮件和电话号码等数据。

3. 采集数据下载离线阅读或存储

4.track 多个市场的价格等

这些软件手动或自动查找新数据、获取新数据或更新数据并存储以方便访问。例如,爬虫可用于从亚马逊采集有关产品及其价格的信息。在这个文章中,我们列出了9个网页抓取工具。

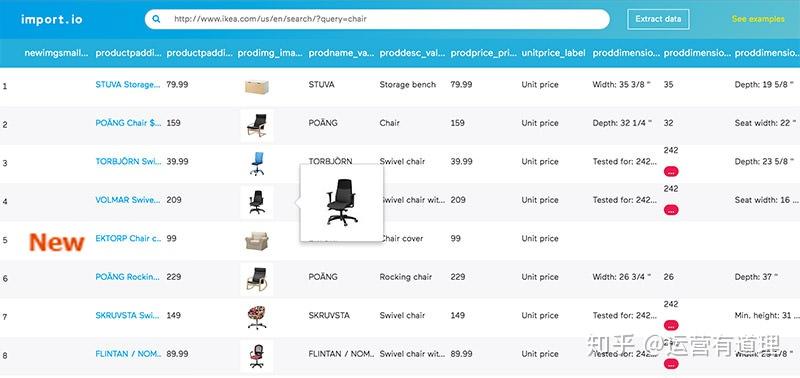

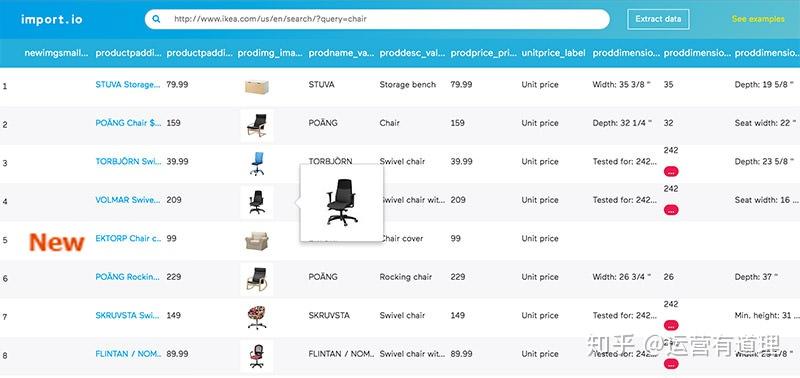

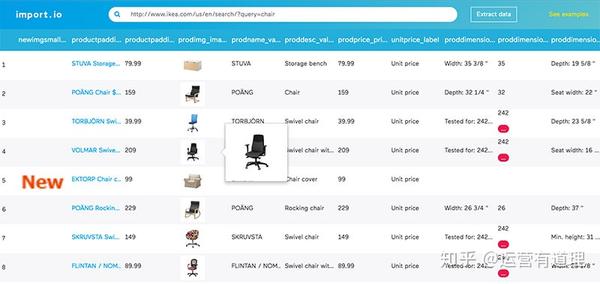

1.Import.io

Import.io 提供了一个构建器,可以通过从特定网页导入数据并将数据导出为 CSV 来形成您自己的数据集。您无需编写任何代码即可在几分钟内轻松抓取数千个网页,并根据您的需求构建 1,000 多个 API。

2.Webhose.io

Webhose.io 通过抓取数千个在线资源提供对实时和结构化数据的直接访问。网络爬虫支持提取超过240种语言的网络数据,并以多种格式保存输出数据,包括XML、JSON和RSS。

3. Dexi.io(原名 CloudScrape)

CloudScrape 支持从任何网站 采集数据,无需像 Webhose 那样下载。它提供了一个基于浏览器的编辑器来设置爬虫并实时提取数据。您可以将采集到的数据保存在 Google Drive 等云平台上,也可以将其导出为 CSV 或 JSON。

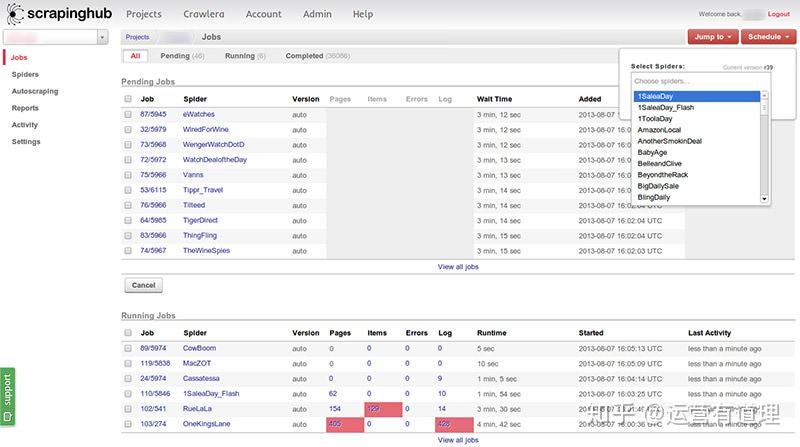

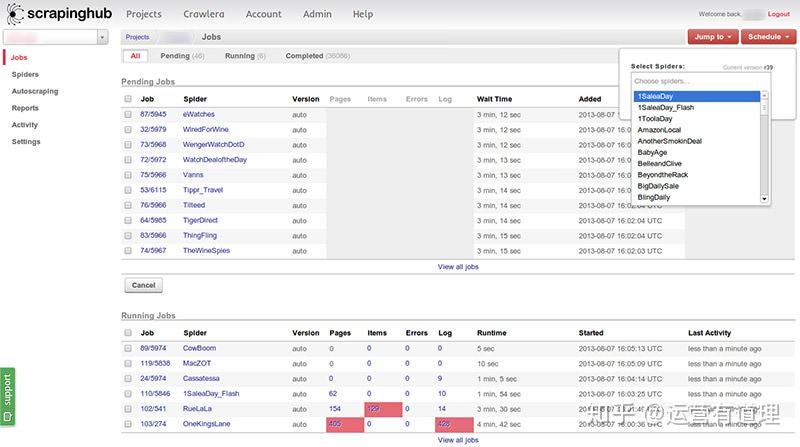

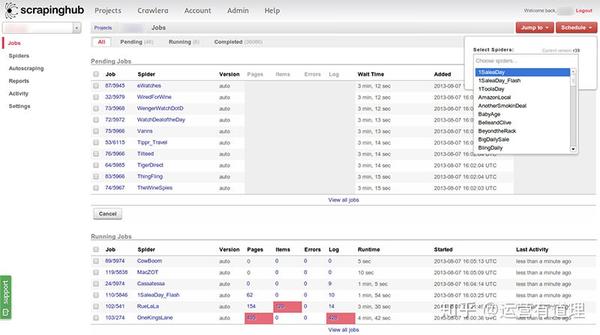

4.Scrapinghub

Scrapinghub 是一种基于云的数据提取工具,可帮助数以千计的开发者获取有价值的数据。 Scrapinghub 使用智能代理微调器 Crawlera,支持绕过机器人反制,轻松抓取大型或受机器人保护的网站。

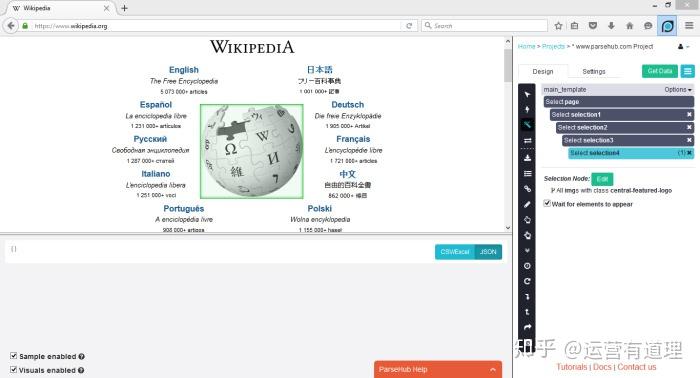

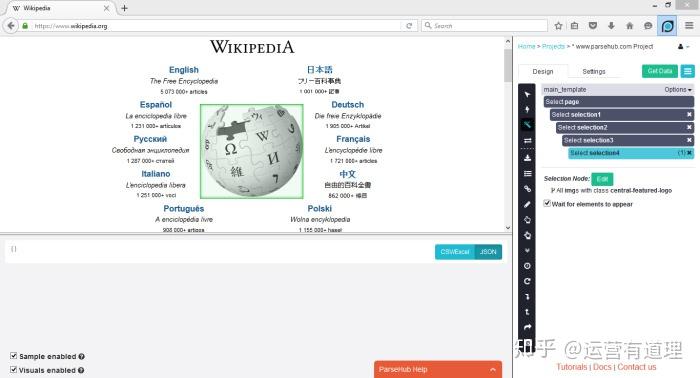

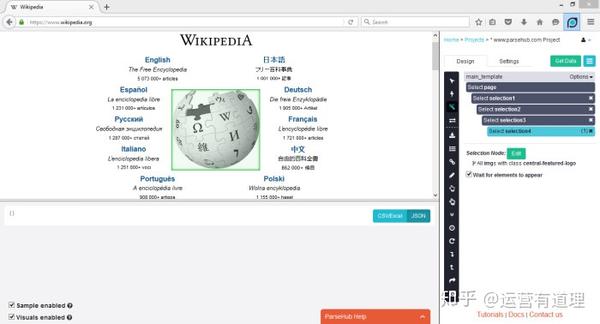

5. ParseHub

ParseHub 用于抓取单个和多个网站,支持 JavaScript、AJAX、会话、cookie 和重定向。该应用程序使用机器学习技术来识别 Web 上最复杂的文档,并根据所需的数据格式生成输出文件。

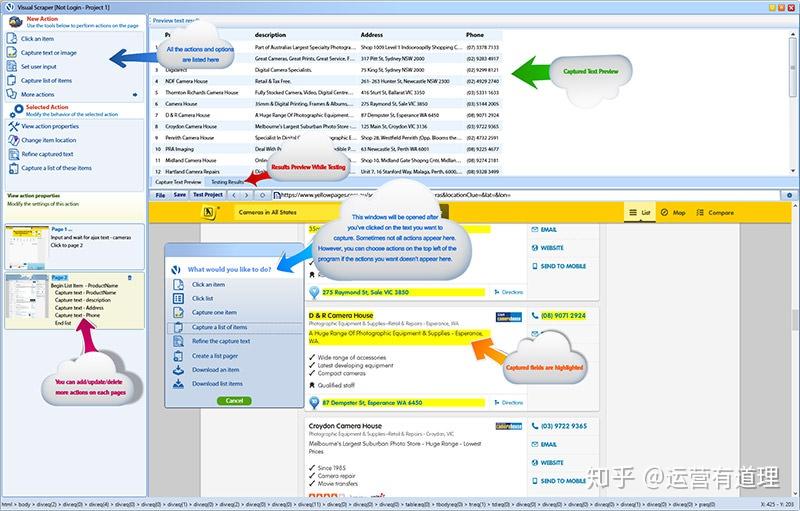

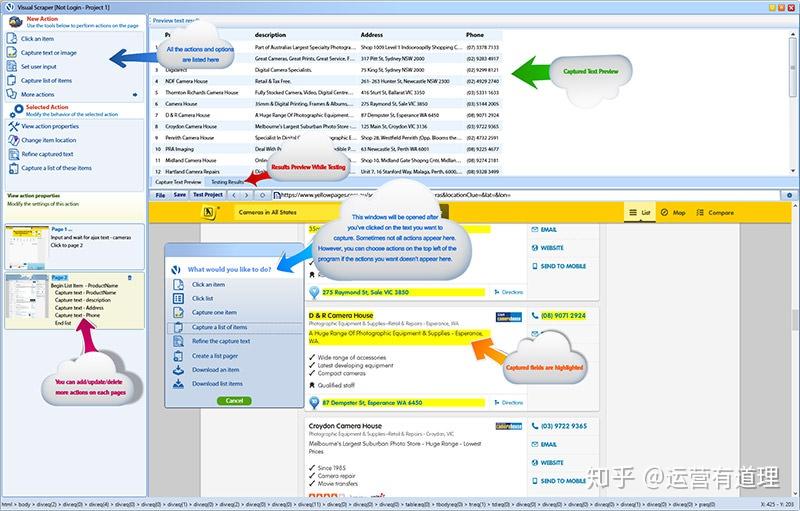

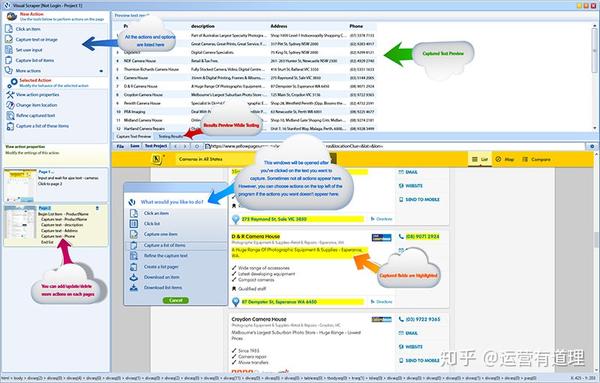

6.VisualScraper

VisualScraper 是另一种网络数据提取软件,可用于从网络采集信息。该软件可以帮助您从多个网页中提取数据并实时获取结果。此外,还可以导出CSV、XML、JSON、SQL等多种格式。

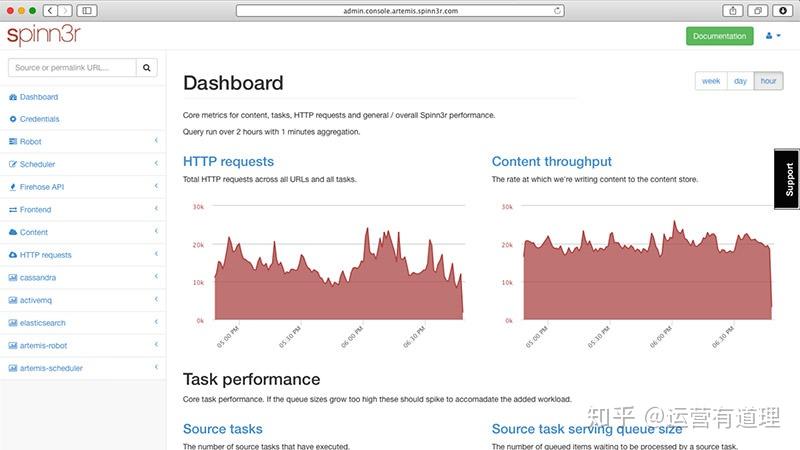

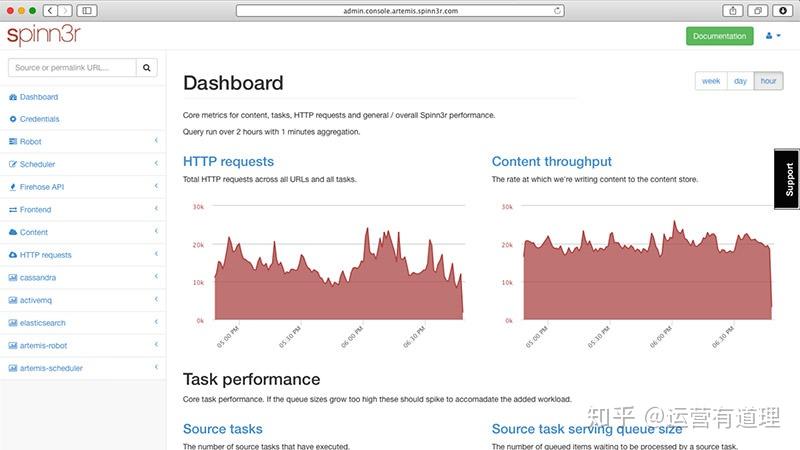

7. Spinn3r

Spinn3r 允许您从博客、新闻和社交媒体 网站 以及 RSS 和 ATOM 提要中获取全部数据。 Spinn3r 与 firehouse API 一起分发并管理 95% 的索引工作。提供先进的垃圾邮件防护,可消除垃圾邮件和不当语言使用,从而提高数据安全性。

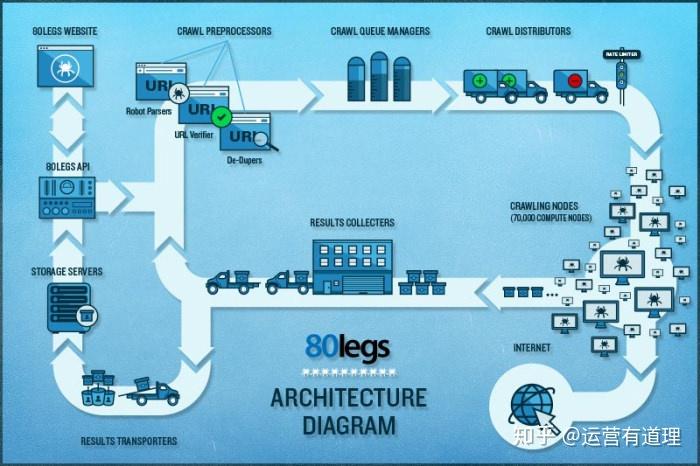

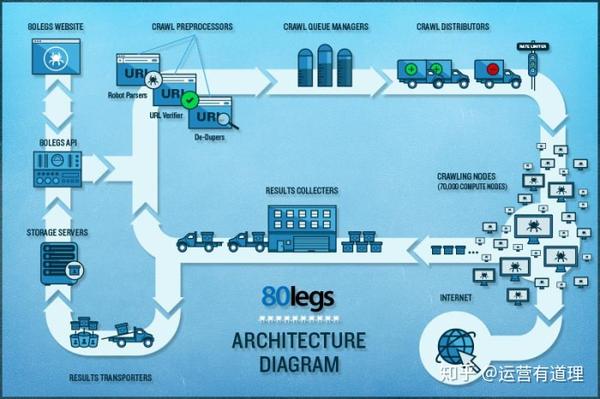

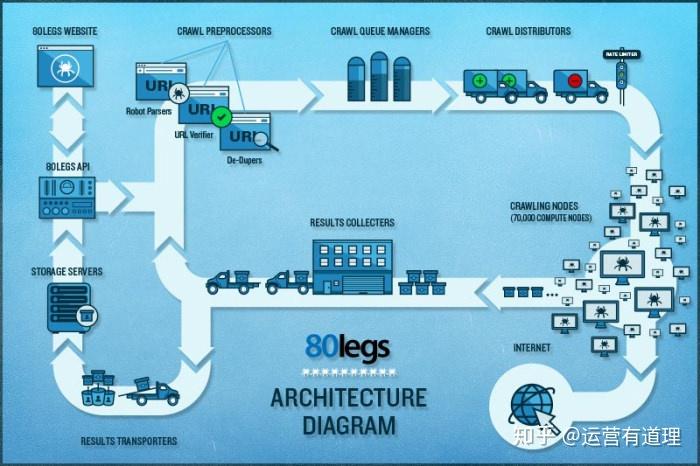

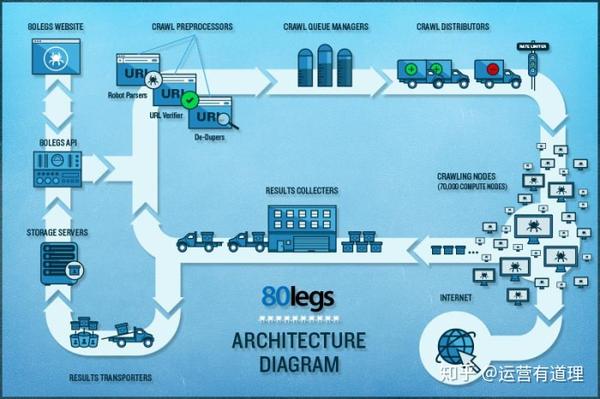

8. 80legs

80legs 是一款功能强大且灵活的网页抓取工具,可根据您的需要进行配置。它支持获取大量数据并立即下载提取数据的选项。 80legs 声称能够抓取超过 600,000 个域,并被 MailChimp 和 PayPal 等大型玩家使用。

9.Scraper

Scraper 是一个 Chrome 扩展,其数据提取功能有限,但它有助于进行在线研究并将数据导出到 Google 电子表格。此工具适合初学者和专家,他们可以使用 OAuth 轻松将数据复制到剪贴板或存储到电子表格。 查看全部

WebScraping支持以240多种语言提取Web数据提取工具

Web Scraping 工具专门用于从网站 中提取信息。它们也称为网络采集工具或网络数据提取工具。

Web Scraping 工具可以在各种场景中用于无限用途。

例如:

1.采集市场调研数据

网页抓取工具可以从多个数据分析提供商处获取信息,并将它们整合到一个位置,以便于参考和分析。可以帮助您及时了解公司或行业未来六个月的发展方向。

2.提取联系方式

这些工具还可用于从各种网站 中提取电子邮件和电话号码等数据。

3. 采集数据下载离线阅读或存储

4.track 多个市场的价格等

这些软件手动或自动查找新数据、获取新数据或更新数据并存储以方便访问。例如,爬虫可用于从亚马逊采集有关产品及其价格的信息。在这个文章中,我们列出了9个网页抓取工具。

1.Import.io

Import.io 提供了一个构建器,可以通过从特定网页导入数据并将数据导出为 CSV 来形成您自己的数据集。您无需编写任何代码即可在几分钟内轻松抓取数千个网页,并根据您的需求构建 1,000 多个 API。

2.Webhose.io

Webhose.io 通过抓取数千个在线资源提供对实时和结构化数据的直接访问。网络爬虫支持提取超过240种语言的网络数据,并以多种格式保存输出数据,包括XML、JSON和RSS。

3. Dexi.io(原名 CloudScrape)

CloudScrape 支持从任何网站 采集数据,无需像 Webhose 那样下载。它提供了一个基于浏览器的编辑器来设置爬虫并实时提取数据。您可以将采集到的数据保存在 Google Drive 等云平台上,也可以将其导出为 CSV 或 JSON。

4.Scrapinghub

Scrapinghub 是一种基于云的数据提取工具,可帮助数以千计的开发者获取有价值的数据。 Scrapinghub 使用智能代理微调器 Crawlera,支持绕过机器人反制,轻松抓取大型或受机器人保护的网站。

5. ParseHub

ParseHub 用于抓取单个和多个网站,支持 JavaScript、AJAX、会话、cookie 和重定向。该应用程序使用机器学习技术来识别 Web 上最复杂的文档,并根据所需的数据格式生成输出文件。

6.VisualScraper

VisualScraper 是另一种网络数据提取软件,可用于从网络采集信息。该软件可以帮助您从多个网页中提取数据并实时获取结果。此外,还可以导出CSV、XML、JSON、SQL等多种格式。

7. Spinn3r

Spinn3r 允许您从博客、新闻和社交媒体 网站 以及 RSS 和 ATOM 提要中获取全部数据。 Spinn3r 与 firehouse API 一起分发并管理 95% 的索引工作。提供先进的垃圾邮件防护,可消除垃圾邮件和不当语言使用,从而提高数据安全性。

8. 80legs

80legs 是一款功能强大且灵活的网页抓取工具,可根据您的需要进行配置。它支持获取大量数据并立即下载提取数据的选项。 80legs 声称能够抓取超过 600,000 个域,并被 MailChimp 和 PayPal 等大型玩家使用。

9.Scraper

Scraper 是一个 Chrome 扩展,其数据提取功能有限,但它有助于进行在线研究并将数据导出到 Google 电子表格。此工具适合初学者和专家,他们可以使用 OAuth 轻松将数据复制到剪贴板或存储到电子表格。

如何通过WebCollector抓取到详情页数据的二次..

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-06-17 04:25

如何通过WebCollector抓取到详情页数据的二次..

前言

上一篇文章我们简单讲过如何通过WebCollector抓取内容,但是这不符合我们的工作需要。在工作过程中,我们通常会抓取某个网页列表下的详情页。数据,这样我们不能简单地从某个列表页面抓取数据,我们需要跳转到详细信息页面进行第二次数据抓取。好了,废话不多说,先从代码开始讲解如何操作。

获取列表信息

假设我们抓取了扫东首页显示文章details的所有内容。如下图所示。

第一步,我们不忙创建爬虫,我们先分析一下我们需要爬取的网站的结构。根据网页的URL地址的特点,我们需要编写正确的正则表达式。如下图。

http://www.jianshu.com/p/700e01a938ce

与我写的文章URL 匹配的正则表达式如下所示。

"http://www.jianshu.com/p/.*"

第二步,正则表达式写好后,我们需要分析一下我们抓到的网站的结构和标签。以谷歌浏览器为例。打开开发者模式控制台。 (F12键Mac commond +alt +i,这里就不啰嗦了),假设我们需要抓取文章的标题和内容。我们先选择“选择工具”(快捷键:commond+shift+c),然后点击标题。标签信息将出现在控制台中。如下图。

我们发现title标签h1的Class为title,如下图。

标题准备好了。接下来,我们来看一下内容。经过以上步骤,我们发现内容在很多标签中。这时候我们只需要获取父标签中的所有内容即可。

顺便说一下,首页的列表页也是如上。如下图,所有超链接都是一个标签。

第三步,我们还是创建了一个继承自AbstractCrawler的爬虫类JianshuCrawler,然后在初始化方法中配置我们的正则表达式和其他一些我们需要爬取的网站Seeds等配置。如下图。

private final static String crawlPath = "/Users/luying/data/db/sports";

private final static String seed = "http://www.jianshu.com/u/e39da354ce50";

private final static String regexRuleString = "http://www.jianshu.com/p/.*";

public JianshuCrawler() {

super(crawlPath, false);

CrawlDatum datum = new CrawlDatum(seed).meta("depth", "2");

addSeed(datum);

this.addRegex(regexRuleString);

setThreads(2);

}

在visit方法中,我们需要做两种处理,一种是爬取文章列表,另一种是爬取文章detail页面的内容。所以我们需要使用详情页URL的正则表达式来区分文章详情页和列表首页的结构如下。

@Override

public void visit(Page page, CrawlDatums next) {

if (page.matchUrl(regexRuleString)) {

//详情页会进入这个模块

} else {

//列表首页会进入这个模块

}

}

通过第二步的分析,我们了解到列表页面需要将所有超链接符合正则表达式的a标签添加到爬取序列中。具体操作如下。

Elements aBodys = page.select("a");

for (int i = 0; i < aBodys.size(); i++) {

Element aElement = aBodys.get(i);

logger.debug("url=" + aElement.attr("abs:href"));

String regEx = regexRuleString;

if (aElement.attr("abs:href").matches(regEx)) {

CrawlDatum datum = new CrawlDatum(aElement.attr("abs:href")).meta("depth", "1").meta("refer",

page.url());

next.add(datum);

} else {

System.out.println("URL不匹配!!");

}

}

对于详情页的逻辑,我们需要抓取对应元素的内容。我们可以使用类名(表单示例:div.xxx)或者id名称(表单示例:div[id=xxx]),这里没有id,所以我们直接使用类名,代码如下。

String title = page.select("h1.title").text();

String content = page.select("div.show-content").text();

我们创建一个 main 函数来创建我们的爬虫对象。然后,我们需要设置爬取深度,因为我们只需要跳转到页面一次,所以我们的爬取深度是2.,最后运行这个类。如下图。

public static void main(String[] args) {

JianshuCrawler crawler = new JianshuCrawler();

crawler.start(2);

}

这样我们就可以在控制台中得到我们想要的数据了。当然,数据的处理这里就不过多解释了。如下图所示。

这个爬虫类的完整代码如下所示。

public class JianshuCrawler extends AbstractCrawler {

private static Logger logger = LoggerFactory.getLogger(JianshuCrawler.class);

private final static String crawlPath = "/Users/luying/data/db/sports";

private final static String seed = "http://www.jianshu.com/u/e39da354ce50";

private final static String regexRuleString = "http://www.jianshu.com/p/.*";

public JianshuCrawler() {

super(crawlPath, false);

CrawlDatum datum = new CrawlDatum(seed).meta("depth", "2");

addSeed(datum);

this.addRegex(regexRuleString);

setThreads(2);

}

@Override

public void visit(Page page, CrawlDatums next) {

if (page.matchUrl(regexRuleString)) {

String title = page.select("h1.title").text();

String content = page.select("div.show-content").text();

System.out.println("标题 " + title);

System.out.println("内容 " + content);

} else {

Elements aBodys = page.select("a");

for (int i = 0; i < aBodys.size(); i++) {

Element aElement = aBodys.get(i);

logger.debug("url=" + aElement.attr("abs:href"));

String regEx = regexRuleString;

if (aElement.attr("abs:href").matches(regEx)) {

CrawlDatum datum = new CrawlDatum(aElement.attr("abs:href")).meta("depth", "1").meta("refer",

page.url());

next.add(datum);

} else {

System.out.println("URL不匹配!!");

}

}

}

}

public static void main(String[] args) {

JianshuCrawler crawler = new JianshuCrawler();

crawler.start(2);

}

}

抓取图片信息

抓图比较简单。假设我们仍然抓取了扫东首页显示的所有图片。如下图。

爬虫类的基本步骤就不一一讲解了,这里说一下访问方面的处理,我们需要网页中标签的属性来做判断。只有html属性和图片的标签属性可以是图像标签。所以我们首先得到如下所示的标签名称。

String contentType = page.response().contentType();

然后判断标签中收录的名称。执行不同的操作,如下所示。

if (contentType == null) {

return;

} else if (contentType.contains("html")) {

// 如果是网页,则抽取其中包含图片的URL,放入后续任务

} else if (contentType.startsWith("image")) {

// 如果是图片,直接下载

}

该标签用于处理网页属性。我们需要把里面的图片地址链接取出来,为下一步做准备。代码如下所示。

Elements imgs = page.select("img[src]");

for (Element img : imgs) {

String imgSrc = img.attr("abs:src");

next.add(imgSrc);

}

如果是图片标签,我们直接取图片的字节数据并存储。代码如下所示。

String extensionName = contentType.split("/")[1];

String imageFileName = imageId.incrementAndGet() + "." + extensionName;

File imageFile = new File(downloadDir, imageFileName);

try {

FileUtils.write(imageFile, page.content());

System.out.println("保存图片 " + page.url() + " 到 " + imageFile.getAbsolutePath());

} catch (IOException ex) {

throw new RuntimeException(ex);

}

因为,标签类型可能是网页,这意味着我们需要跳转到下一层页面。这时候我们在main函数中创建一个对象,需要设置爬取深度为2.

public static void main(String[] args) throws Exception {

JianshuImageCrawler crawler = new JianshuImageCrawler();

crawler.start(2);

}

图片的存储过程就不过多解释了。通过运行,我们可以在对应的存储路径下找到我们的图片。如下图。

整体代码如下所示。

package com.infosports.yuqingmanagement.crawler.impl;

import java.io.File;

import java.io.IOException;

import java.util.concurrent.atomic.AtomicInteger;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import cn.edu.hfut.dmic.webcollector.model.CrawlDatum;

import cn.edu.hfut.dmic.webcollector.model.CrawlDatums;

import cn.edu.hfut.dmic.webcollector.model.Page;

import cn.edu.hfut.dmic.webcollector.plugin.berkeley.BreadthCrawler;

import cn.edu.hfut.dmic.webcollector.util.FileUtils;

import cn.edu.hfut.dmic.webcollector.util.RegexRule;

public class JianshuImageCrawler extends BreadthCrawler {

// 用于保存图片的文件夹

File downloadDir;

// 原子性int,用于生成图片文件名

AtomicInteger imageId;

private final static String crawlPath = "/Users/luying/data/db/jianshu";

private final static String downPath = "/Users/luying/data/db/jianshuImage";

private final static String seed = "http://www.jianshu.com/u/e39da354ce50";

RegexRule regexRule = new RegexRule();

public JianshuImageCrawler() {

super(crawlPath, false);

downloadDir = new File(downPath);

if (!downloadDir.exists()) {

downloadDir.mkdirs();

}

computeImageId();

CrawlDatum datum = new CrawlDatum(seed).meta("depth", "2");

addSeed(datum);

regexRule.addRule("http://.*");

}

@Override

public void visit(Page page, CrawlDatums next) {

String contentType = page.response().contentType();

if (contentType == null) {

return;

} else if (contentType.contains("html")) {

// 如果是网页,则抽取其中包含图片的URL,放入后续任务

Elements imgs = page.select("img[src]");

for (Element img : imgs) {

String imgSrc = img.attr("abs:src");

next.add(imgSrc);

}

} else if (contentType.startsWith("image")) {

// 如果是图片,直接下载

String extensionName = contentType.split("/")[1];

String imageFileName = imageId.incrementAndGet() + "." + extensionName;

File imageFile = new File(downloadDir, imageFileName);

try {

FileUtils.write(imageFile, page.content());

System.out.println("保存图片 " + page.url() + " 到 " + imageFile.getAbsolutePath());

} catch (IOException ex) {

throw new RuntimeException(ex);

}

}

}

public void computeImageId() {

int maxId = -1;

for (File imageFile : downloadDir.listFiles()) {

String fileName = imageFile.getName();

String idStr = fileName.split("\\.")[0];

int id = Integer.valueOf(idStr);

if (id > maxId) {

maxId = id;

}

}

imageId = new AtomicInteger(maxId);

}

public static void main(String[] args) throws Exception {

// TODO Auto-generated method stub

JianshuImageCrawler crawler = new JianshuImageCrawler();

crawler.start(2);

}

总结

本篇博客写到最后,分享技术点的过程还没有结束。当然,毕竟我很久没学Java了,所以文章很多概念可能比较模糊,所以如果有错误,欢迎指导批评,非常感谢。

查看全部

如何通过WebCollector抓取到详情页数据的二次..

前言

上一篇文章我们简单讲过如何通过WebCollector抓取内容,但是这不符合我们的工作需要。在工作过程中,我们通常会抓取某个网页列表下的详情页。数据,这样我们不能简单地从某个列表页面抓取数据,我们需要跳转到详细信息页面进行第二次数据抓取。好了,废话不多说,先从代码开始讲解如何操作。

获取列表信息

假设我们抓取了扫东首页显示文章details的所有内容。如下图所示。

第一步,我们不忙创建爬虫,我们先分析一下我们需要爬取的网站的结构。根据网页的URL地址的特点,我们需要编写正确的正则表达式。如下图。

http://www.jianshu.com/p/700e01a938ce

与我写的文章URL 匹配的正则表达式如下所示。

"http://www.jianshu.com/p/.*"

第二步,正则表达式写好后,我们需要分析一下我们抓到的网站的结构和标签。以谷歌浏览器为例。打开开发者模式控制台。 (F12键Mac commond +alt +i,这里就不啰嗦了),假设我们需要抓取文章的标题和内容。我们先选择“选择工具”(快捷键:commond+shift+c),然后点击标题。标签信息将出现在控制台中。如下图。

我们发现title标签h1的Class为title,如下图。

标题准备好了。接下来,我们来看一下内容。经过以上步骤,我们发现内容在很多标签中。这时候我们只需要获取父标签中的所有内容即可。

顺便说一下,首页的列表页也是如上。如下图,所有超链接都是一个标签。

第三步,我们还是创建了一个继承自AbstractCrawler的爬虫类JianshuCrawler,然后在初始化方法中配置我们的正则表达式和其他一些我们需要爬取的网站Seeds等配置。如下图。

private final static String crawlPath = "/Users/luying/data/db/sports";

private final static String seed = "http://www.jianshu.com/u/e39da354ce50";

private final static String regexRuleString = "http://www.jianshu.com/p/.*";

public JianshuCrawler() {

super(crawlPath, false);

CrawlDatum datum = new CrawlDatum(seed).meta("depth", "2");

addSeed(datum);

this.addRegex(regexRuleString);

setThreads(2);

}

在visit方法中,我们需要做两种处理,一种是爬取文章列表,另一种是爬取文章detail页面的内容。所以我们需要使用详情页URL的正则表达式来区分文章详情页和列表首页的结构如下。

@Override

public void visit(Page page, CrawlDatums next) {

if (page.matchUrl(regexRuleString)) {

//详情页会进入这个模块

} else {

//列表首页会进入这个模块

}

}

通过第二步的分析,我们了解到列表页面需要将所有超链接符合正则表达式的a标签添加到爬取序列中。具体操作如下。

Elements aBodys = page.select("a");

for (int i = 0; i < aBodys.size(); i++) {

Element aElement = aBodys.get(i);

logger.debug("url=" + aElement.attr("abs:href"));

String regEx = regexRuleString;

if (aElement.attr("abs:href").matches(regEx)) {

CrawlDatum datum = new CrawlDatum(aElement.attr("abs:href")).meta("depth", "1").meta("refer",

page.url());

next.add(datum);

} else {

System.out.println("URL不匹配!!");

}

}

对于详情页的逻辑,我们需要抓取对应元素的内容。我们可以使用类名(表单示例:div.xxx)或者id名称(表单示例:div[id=xxx]),这里没有id,所以我们直接使用类名,代码如下。

String title = page.select("h1.title").text();

String content = page.select("div.show-content").text();

我们创建一个 main 函数来创建我们的爬虫对象。然后,我们需要设置爬取深度,因为我们只需要跳转到页面一次,所以我们的爬取深度是2.,最后运行这个类。如下图。

public static void main(String[] args) {

JianshuCrawler crawler = new JianshuCrawler();

crawler.start(2);

}

这样我们就可以在控制台中得到我们想要的数据了。当然,数据的处理这里就不过多解释了。如下图所示。

这个爬虫类的完整代码如下所示。

public class JianshuCrawler extends AbstractCrawler {

private static Logger logger = LoggerFactory.getLogger(JianshuCrawler.class);

private final static String crawlPath = "/Users/luying/data/db/sports";

private final static String seed = "http://www.jianshu.com/u/e39da354ce50";

private final static String regexRuleString = "http://www.jianshu.com/p/.*";

public JianshuCrawler() {

super(crawlPath, false);

CrawlDatum datum = new CrawlDatum(seed).meta("depth", "2");

addSeed(datum);

this.addRegex(regexRuleString);

setThreads(2);

}

@Override

public void visit(Page page, CrawlDatums next) {

if (page.matchUrl(regexRuleString)) {

String title = page.select("h1.title").text();

String content = page.select("div.show-content").text();

System.out.println("标题 " + title);

System.out.println("内容 " + content);

} else {

Elements aBodys = page.select("a");

for (int i = 0; i < aBodys.size(); i++) {

Element aElement = aBodys.get(i);

logger.debug("url=" + aElement.attr("abs:href"));

String regEx = regexRuleString;

if (aElement.attr("abs:href").matches(regEx)) {

CrawlDatum datum = new CrawlDatum(aElement.attr("abs:href")).meta("depth", "1").meta("refer",

page.url());

next.add(datum);

} else {

System.out.println("URL不匹配!!");

}

}

}

}

public static void main(String[] args) {

JianshuCrawler crawler = new JianshuCrawler();

crawler.start(2);

}

}

抓取图片信息

抓图比较简单。假设我们仍然抓取了扫东首页显示的所有图片。如下图。

爬虫类的基本步骤就不一一讲解了,这里说一下访问方面的处理,我们需要网页中标签的属性来做判断。只有html属性和图片的标签属性可以是图像标签。所以我们首先得到如下所示的标签名称。

String contentType = page.response().contentType();

然后判断标签中收录的名称。执行不同的操作,如下所示。

if (contentType == null) {

return;

} else if (contentType.contains("html")) {

// 如果是网页,则抽取其中包含图片的URL,放入后续任务

} else if (contentType.startsWith("image")) {

// 如果是图片,直接下载

}

该标签用于处理网页属性。我们需要把里面的图片地址链接取出来,为下一步做准备。代码如下所示。

Elements imgs = page.select("img[src]");

for (Element img : imgs) {

String imgSrc = img.attr("abs:src");

next.add(imgSrc);

}

如果是图片标签,我们直接取图片的字节数据并存储。代码如下所示。

String extensionName = contentType.split("/")[1];

String imageFileName = imageId.incrementAndGet() + "." + extensionName;

File imageFile = new File(downloadDir, imageFileName);

try {

FileUtils.write(imageFile, page.content());

System.out.println("保存图片 " + page.url() + " 到 " + imageFile.getAbsolutePath());

} catch (IOException ex) {

throw new RuntimeException(ex);

}

因为,标签类型可能是网页,这意味着我们需要跳转到下一层页面。这时候我们在main函数中创建一个对象,需要设置爬取深度为2.

public static void main(String[] args) throws Exception {

JianshuImageCrawler crawler = new JianshuImageCrawler();

crawler.start(2);

}

图片的存储过程就不过多解释了。通过运行,我们可以在对应的存储路径下找到我们的图片。如下图。

整体代码如下所示。

package com.infosports.yuqingmanagement.crawler.impl;

import java.io.File;

import java.io.IOException;

import java.util.concurrent.atomic.AtomicInteger;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import cn.edu.hfut.dmic.webcollector.model.CrawlDatum;

import cn.edu.hfut.dmic.webcollector.model.CrawlDatums;

import cn.edu.hfut.dmic.webcollector.model.Page;

import cn.edu.hfut.dmic.webcollector.plugin.berkeley.BreadthCrawler;

import cn.edu.hfut.dmic.webcollector.util.FileUtils;

import cn.edu.hfut.dmic.webcollector.util.RegexRule;

public class JianshuImageCrawler extends BreadthCrawler {

// 用于保存图片的文件夹

File downloadDir;

// 原子性int,用于生成图片文件名

AtomicInteger imageId;

private final static String crawlPath = "/Users/luying/data/db/jianshu";

private final static String downPath = "/Users/luying/data/db/jianshuImage";

private final static String seed = "http://www.jianshu.com/u/e39da354ce50";

RegexRule regexRule = new RegexRule();

public JianshuImageCrawler() {

super(crawlPath, false);

downloadDir = new File(downPath);

if (!downloadDir.exists()) {

downloadDir.mkdirs();

}

computeImageId();

CrawlDatum datum = new CrawlDatum(seed).meta("depth", "2");

addSeed(datum);

regexRule.addRule("http://.*");

}

@Override

public void visit(Page page, CrawlDatums next) {

String contentType = page.response().contentType();

if (contentType == null) {

return;

} else if (contentType.contains("html")) {

// 如果是网页,则抽取其中包含图片的URL,放入后续任务

Elements imgs = page.select("img[src]");

for (Element img : imgs) {

String imgSrc = img.attr("abs:src");

next.add(imgSrc);

}

} else if (contentType.startsWith("image")) {

// 如果是图片,直接下载

String extensionName = contentType.split("/")[1];

String imageFileName = imageId.incrementAndGet() + "." + extensionName;

File imageFile = new File(downloadDir, imageFileName);

try {

FileUtils.write(imageFile, page.content());

System.out.println("保存图片 " + page.url() + " 到 " + imageFile.getAbsolutePath());

} catch (IOException ex) {

throw new RuntimeException(ex);

}

}

}

public void computeImageId() {

int maxId = -1;

for (File imageFile : downloadDir.listFiles()) {

String fileName = imageFile.getName();

String idStr = fileName.split("\\.")[0];

int id = Integer.valueOf(idStr);

if (id > maxId) {

maxId = id;

}

}

imageId = new AtomicInteger(maxId);

}

public static void main(String[] args) throws Exception {

// TODO Auto-generated method stub

JianshuImageCrawler crawler = new JianshuImageCrawler();

crawler.start(2);

}

总结

本篇博客写到最后,分享技术点的过程还没有结束。当然,毕竟我很久没学Java了,所以文章很多概念可能比较模糊,所以如果有错误,欢迎指导批评,非常感谢。

避开抓取陷阱的目的是克服网站阻止自动抓取这个障碍

网站优化 • 优采云 发表了文章 • 0 个评论 • 157 次浏览 • 2021-07-03 19:37

避免爬虫陷阱的目的是克服网站防止自动爬虫。

1.道德标准

注意:此处演示的许多程序和技术不应用于任何网站。这不仅很糟糕,而且您还可能会收到一封警告信,要求您停止,甚至可能会发生更糟糕的事情。

2.让网络机器人看起来像人类用户

网站反爬虫的前提是正确区分人类用户和网络机器人。有很多方法可以让您的网络机器人看起来更像人类用户。

(1)Modify 请求头

HTTP 请求头是每次向 Web 服务器发送请求时传递的一组属性或配置信息。 HTTP 请求有多种类型。大多数浏览器仅使用这 7 个字段来初始化所有网络请求:Host、Connection、Accept、User-Agent、Referrer、Accept-Encoding、Accept-Language。经典的 Python 爬虫在使用 urllib 标准库时会发送 Accept-Encoding 和 User-Agent。

可以使用 Requests 库配置请求标头。

书中代码:(执行被拦截,如果执行成功:程序输出中的请求头应该和程序中设置的头一致。)

import requests

from bs4 import BeautifulSoup

session = requests.Session()

headers = {'User-Agent':'Mozilla/5.0(Macintosh; Intel Mac OS X 10_9_5)AppleWebKit 537.36 (KHTML, like Gecko) Chrome', 'Accept':'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8'}

url = 'https://www.whatismybrowser.co ... 39%3B

req = session.get(url, headers=headers)

bs = BeautifulSoup(req.text, 'html.parser')

print(bs.find('table', {'class':'table-striped'}).get_text)

也许网站会检查HTTP请求头的每一个属性,通常真正重要的参数是User-Agent。不管你在做什么项目,一定要记得把User-Agent属性设置成不容易引起怀疑的东西,不要使用Python-urllib/3.4。对于非常警觉的网站,注意那些经常使用但很少检查的请求头,比如Accept-Language属性。

很多大的网站会为相同的内容提供不同的语言翻译,根据请求头的参数响应不同的语言版本。有时只需要将请求头属性从 Accept-Language:en-US 修改为 Accept-Language:fr 即可获得法语版本的页面。请求头也可以让网站改变内容的布局风格,修改User-Agent。

(2)使用JavaScript处理cookies

通过正确处理 cookie,可以避免许多抓取问题。 网站 将使用 cookie 来跟踪您的访问。如果发现有异常行为的爬虫,其访问将被中断,例如非常快速地填写表格,或浏览大量页面。

有些网站 不需要您每次登录时都获取新的 cookie。您可以通过保存旧的“登录”cookie 来访问 网站。

某些浏览器插件可以显示您访问网站 和浏览网站 时cookie 是如何设置的。 (EditThisCookie)

Requests模块对cookies的处理请参考第十章文章5th小节内容。

请求库无法执行 JavaScript,因此无法处理现代跟踪软件(例如 Google Analytics)生成的许多 cookie。 cookie 仅在客户端脚本执行时设置(或根据用户浏览页面时按钮点击等 Web 事件生成 cookie)。需要用到Selenium和PhantomJS包(安装和使用在第11章文章)

使用任意网站调用webdriver的get_cookie()方法查看cookies(cookie列表):

from selenium import webdriver

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com')

driver.implicitly_wait(1)

print(driver.get_cookies())

您还可以调用 delete_cookie()、add_cookie() 和 delete_all_cookies() 方法来处理 cookie。此外,可以保存 cookie 以供其他网络爬虫使用。 (driver2的cookies打印失败,找不到原因)

# -*- coding:GBK -*-

from selenium import webdriver

#driver = webdriver.Chrome(r'C:\Users\Administrator\AppData\Local\Google\Chrome\Application\chromedriver.exe')

# 尝试webdriver.PhantomJS()内添加service_args=['--ignore-ssl-errors=true', '--ssl-protocol=TLSv1'],扔执行失败

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com')

driver.implicitly_wait(1)

savedCookies = driver.get_cookies()

print(savedCookies)

#driver2 = webdriver.Chrome(r'C:\Users\Administrator\AppData\Local\Google\Chrome\Application\chromedriver.exe')

driver2 = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver2.get('http://pythonscraping.com')

driver2.delete_all_cookies()

for cookie in savedCookies:

if not cookie['domain'].startswith('.'):

cookie['domain'] = '.{}'.format(cookie['domain']) #PhantomJS的规则——添加cookie的所有域名都要以.字符开头

driver2.add_cookie(cookie)

driver2.get('http://pythonscraping.com')

driver.implicitly_wait(1)

print(driver2.get_cookies())

(3)时间就是一切

一些具有完整保护措施的网站可能会阻止您快速提交表单或与网站快速交互。以比普通人快得多的速度从网站下载大量信息,也可能导致自己被网站屏蔽。

多线程程序可能是快速加载页面的好方法,但这对于编写良好的爬虫来说仍然是一个糟糕的策略。应该尽量确保页面加载和数据请求最小化。如果可能,尝试在页面访问之间添加几秒钟(使用以下代码)。有时候,我们必须学会撤退!

import time

time.sleep(3)

3.通用表单安全措施

Web 表单,尤其是用于创建和登录帐户的表单,如果被机器人滥用,将对网站 的安全性和计算开销构成严重威胁。因此,试图限制网站 的访问是最适合许多网站 所有者的利益。 (有关处理受保护表单的更多信息,请参阅第 13 部分和第 17 部分)

(1)隐式输入字段值

在HTML表单中,“隐藏”字段用于使该字段的值对浏览器可见,但对用户不可见(除非你看到

网页源代码)。

有两种主要方法可以阻止带有隐藏字段的网络爬行:

第一个是表单页面上的一个字段可以填充由服务器生成的随机变量。 (规避这个问题最好的办法是先抓取表单所在页面生成的随机变量,然后提交到表单处理页面。)

第二种方法是“蜜罐”。服务器会忽略所有隐藏字段的真实值(或表单提交页面上与默认值不同的值),填写隐藏字段的用户甚至可能被网站屏蔽。总之,有时候需要检查一下表单所在的页面,看看有没有服务器预设的隐藏字段(蜜罐陷阱)缺失或者错误。此外,还有其他检查可以用来确保当前生成的表单变量只使用过一次或最近生成过(这可以防止变量简单地存储在程序中重复使用)。

(2)避免蜜罐

如果web表单的某个字段通过CSS设置为用户不可见,那么普通用户在访问网站时无法填写该字段。如果填写了这个字段,很可能是机器人做了,所以这个提交会作废。这种方法也适用于链接、图片、文件以及任何机器人可以读取但普通用户在浏览器中看不到的内容。

查看网站的源码,通过CSS隐藏了一个链接(属性设置display:none)和两个隐藏字段(type="hidden",元素移动到了显示和滚动的边界之外bar 被隐藏,导致元素不可见)。

Selenium 可以获取访问页面的内容,因此可以区分页面上的可见元素和隐藏元素。使用 is_displayed() 判断该元素在页面上是否可见。

以下代码查找上面网站的隐藏元素:

from selenium import webdriver

from selenium.webdriver.remote.webelement import WebElement

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com/page ... %2339;)

links = driver.find_elements_by_tag_name('a')

for link in links:

if not link.is_displayed():

print('The link {} is a trap'.format(link.get_attribute('href')))

fields = driver.find_elements_by_tag_name('input')

for field in fields:

if not field.is_displayed():

print('Do not change value of {}'.format(field.get_attribute('name')))

简而言之,简单地忽略隐藏字段是危险的,但在与它们交互时必须小心。

4.问题清单 查看全部

避开抓取陷阱的目的是克服网站阻止自动抓取这个障碍

避免爬虫陷阱的目的是克服网站防止自动爬虫。

1.道德标准

注意:此处演示的许多程序和技术不应用于任何网站。这不仅很糟糕,而且您还可能会收到一封警告信,要求您停止,甚至可能会发生更糟糕的事情。

2.让网络机器人看起来像人类用户

网站反爬虫的前提是正确区分人类用户和网络机器人。有很多方法可以让您的网络机器人看起来更像人类用户。

(1)Modify 请求头

HTTP 请求头是每次向 Web 服务器发送请求时传递的一组属性或配置信息。 HTTP 请求有多种类型。大多数浏览器仅使用这 7 个字段来初始化所有网络请求:Host、Connection、Accept、User-Agent、Referrer、Accept-Encoding、Accept-Language。经典的 Python 爬虫在使用 urllib 标准库时会发送 Accept-Encoding 和 User-Agent。

可以使用 Requests 库配置请求标头。

书中代码:(执行被拦截,如果执行成功:程序输出中的请求头应该和程序中设置的头一致。)

import requests

from bs4 import BeautifulSoup

session = requests.Session()

headers = {'User-Agent':'Mozilla/5.0(Macintosh; Intel Mac OS X 10_9_5)AppleWebKit 537.36 (KHTML, like Gecko) Chrome', 'Accept':'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8'}

url = 'https://www.whatismybrowser.co ... 39%3B

req = session.get(url, headers=headers)

bs = BeautifulSoup(req.text, 'html.parser')

print(bs.find('table', {'class':'table-striped'}).get_text)

也许网站会检查HTTP请求头的每一个属性,通常真正重要的参数是User-Agent。不管你在做什么项目,一定要记得把User-Agent属性设置成不容易引起怀疑的东西,不要使用Python-urllib/3.4。对于非常警觉的网站,注意那些经常使用但很少检查的请求头,比如Accept-Language属性。

很多大的网站会为相同的内容提供不同的语言翻译,根据请求头的参数响应不同的语言版本。有时只需要将请求头属性从 Accept-Language:en-US 修改为 Accept-Language:fr 即可获得法语版本的页面。请求头也可以让网站改变内容的布局风格,修改User-Agent。

(2)使用JavaScript处理cookies

通过正确处理 cookie,可以避免许多抓取问题。 网站 将使用 cookie 来跟踪您的访问。如果发现有异常行为的爬虫,其访问将被中断,例如非常快速地填写表格,或浏览大量页面。

有些网站 不需要您每次登录时都获取新的 cookie。您可以通过保存旧的“登录”cookie 来访问 网站。

某些浏览器插件可以显示您访问网站 和浏览网站 时cookie 是如何设置的。 (EditThisCookie)

Requests模块对cookies的处理请参考第十章文章5th小节内容。

请求库无法执行 JavaScript,因此无法处理现代跟踪软件(例如 Google Analytics)生成的许多 cookie。 cookie 仅在客户端脚本执行时设置(或根据用户浏览页面时按钮点击等 Web 事件生成 cookie)。需要用到Selenium和PhantomJS包(安装和使用在第11章文章)

使用任意网站调用webdriver的get_cookie()方法查看cookies(cookie列表):

from selenium import webdriver

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com')

driver.implicitly_wait(1)

print(driver.get_cookies())

您还可以调用 delete_cookie()、add_cookie() 和 delete_all_cookies() 方法来处理 cookie。此外,可以保存 cookie 以供其他网络爬虫使用。 (driver2的cookies打印失败,找不到原因)

# -*- coding:GBK -*-

from selenium import webdriver

#driver = webdriver.Chrome(r'C:\Users\Administrator\AppData\Local\Google\Chrome\Application\chromedriver.exe')

# 尝试webdriver.PhantomJS()内添加service_args=['--ignore-ssl-errors=true', '--ssl-protocol=TLSv1'],扔执行失败

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com')

driver.implicitly_wait(1)

savedCookies = driver.get_cookies()

print(savedCookies)

#driver2 = webdriver.Chrome(r'C:\Users\Administrator\AppData\Local\Google\Chrome\Application\chromedriver.exe')

driver2 = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver2.get('http://pythonscraping.com')

driver2.delete_all_cookies()

for cookie in savedCookies:

if not cookie['domain'].startswith('.'):

cookie['domain'] = '.{}'.format(cookie['domain']) #PhantomJS的规则——添加cookie的所有域名都要以.字符开头

driver2.add_cookie(cookie)

driver2.get('http://pythonscraping.com')

driver.implicitly_wait(1)

print(driver2.get_cookies())

(3)时间就是一切

一些具有完整保护措施的网站可能会阻止您快速提交表单或与网站快速交互。以比普通人快得多的速度从网站下载大量信息,也可能导致自己被网站屏蔽。

多线程程序可能是快速加载页面的好方法,但这对于编写良好的爬虫来说仍然是一个糟糕的策略。应该尽量确保页面加载和数据请求最小化。如果可能,尝试在页面访问之间添加几秒钟(使用以下代码)。有时候,我们必须学会撤退!

import time

time.sleep(3)

3.通用表单安全措施

Web 表单,尤其是用于创建和登录帐户的表单,如果被机器人滥用,将对网站 的安全性和计算开销构成严重威胁。因此,试图限制网站 的访问是最适合许多网站 所有者的利益。 (有关处理受保护表单的更多信息,请参阅第 13 部分和第 17 部分)

(1)隐式输入字段值

在HTML表单中,“隐藏”字段用于使该字段的值对浏览器可见,但对用户不可见(除非你看到

网页源代码)。

有两种主要方法可以阻止带有隐藏字段的网络爬行:

第一个是表单页面上的一个字段可以填充由服务器生成的随机变量。 (规避这个问题最好的办法是先抓取表单所在页面生成的随机变量,然后提交到表单处理页面。)

第二种方法是“蜜罐”。服务器会忽略所有隐藏字段的真实值(或表单提交页面上与默认值不同的值),填写隐藏字段的用户甚至可能被网站屏蔽。总之,有时候需要检查一下表单所在的页面,看看有没有服务器预设的隐藏字段(蜜罐陷阱)缺失或者错误。此外,还有其他检查可以用来确保当前生成的表单变量只使用过一次或最近生成过(这可以防止变量简单地存储在程序中重复使用)。

(2)避免蜜罐

如果web表单的某个字段通过CSS设置为用户不可见,那么普通用户在访问网站时无法填写该字段。如果填写了这个字段,很可能是机器人做了,所以这个提交会作废。这种方法也适用于链接、图片、文件以及任何机器人可以读取但普通用户在浏览器中看不到的内容。

查看网站的源码,通过CSS隐藏了一个链接(属性设置display:none)和两个隐藏字段(type="hidden",元素移动到了显示和滚动的边界之外bar 被隐藏,导致元素不可见)。

Selenium 可以获取访问页面的内容,因此可以区分页面上的可见元素和隐藏元素。使用 is_displayed() 判断该元素在页面上是否可见。

以下代码查找上面网站的隐藏元素:

from selenium import webdriver

from selenium.webdriver.remote.webelement import WebElement

driver = webdriver.PhantomJS(executable_path='D:/Web_crawler/phantomjs-2.1.1-windows/bin/phantomjs.exe')

driver.get('http://pythonscraping.com/page ... %2339;)

links = driver.find_elements_by_tag_name('a')

for link in links:

if not link.is_displayed():

print('The link {} is a trap'.format(link.get_attribute('href')))

fields = driver.find_elements_by_tag_name('input')

for field in fields:

if not field.is_displayed():

print('Do not change value of {}'.format(field.get_attribute('name')))

简而言之,简单地忽略隐藏字段是危险的,但在与它们交互时必须小心。

4.问题清单

图片到底是怎么抓取的呢?图片优化是个细节问题

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-07-03 06:40

一个网站如果所有密集的文本对用户体验非常不利,同时我不想在网站上停留一分钟或一秒钟。 网站在开发的时候,会在页面上加很多图片来美化和体验更好,但是图片对于搜索引擎的蜘蛛爬行能力不如文章,文字少,很多图片。会对seo优化造成一定的困难。

图片是如何拍摄的?

1、 是最好的原创 图片。图片还是自己做的。您可以使用免费图片拼接成我们想要的图片。请勿盗图。

<p>2.为了方便蜘蛛爬取,上传图片到网站时,最好将所有图片按照网站一栏放在对应的图片目录,或者放在一个文件夹中。 查看全部

图片到底是怎么抓取的呢?图片优化是个细节问题

一个网站如果所有密集的文本对用户体验非常不利,同时我不想在网站上停留一分钟或一秒钟。 网站在开发的时候,会在页面上加很多图片来美化和体验更好,但是图片对于搜索引擎的蜘蛛爬行能力不如文章,文字少,很多图片。会对seo优化造成一定的困难。

图片是如何拍摄的?

1、 是最好的原创 图片。图片还是自己做的。您可以使用免费图片拼接成我们想要的图片。请勿盗图。

<p>2.为了方便蜘蛛爬取,上传图片到网站时,最好将所有图片按照网站一栏放在对应的图片目录,或者放在一个文件夹中。

彻底解决网站内容的收集和捕获要解决企业网站的收录问题

网站优化 • 优采云 发表了文章 • 0 个评论 • 95 次浏览 • 2021-07-03 06:30

通过做网站,只有彻底解决网站的收录和抓取问题,才能最大化网站的价值,实现这样的网站内容不管数量还是质量。以上有待改进。 网站 结构对用户和蜘蛛都有利,因为蜘蛛和用户相辅相成。只有通过网站同时满足要求才是好的网站。

彻底解决网站内容的采集和抓取

解决企业网站的收录问题,首先要制定步骤,了解学生搜索引擎蜘蛛的工作方法。首先,蜘蛛需要到达你的网站,所以除了固定蜘蛛来的方式外,我们还可以主动引导他抓取我们的内容,如果没有抓到我们,我们可以主动提交给他。 (善用百度站长平台的主动提交、手动提交和站点地图)

彻底解决网站内容的采集和抓取

蜘蛛到达我们的网站。对于我们的国家,我们仍然需要让他高兴地抓住它。这涉及到网站主要内容的可识别性,下载页面设计能否顺利下载,产品信息页面是否描述清楚等等。

彻底解决网站内容的采集和抓取

蜘蛛抓取成功后,会将内容放入索引库中进行过滤比较,然后在用户搜索相关关键词时显示出来。索引就是我们通常所说的收录、收录,它只是表示你的页面存在于搜索引擎的索引库中,并不代表它被显示出来。

重要的是蜘蛛是否会抓取您的页面,是否会抓取高质量的页面,以及客户搜索关键字时您的页面是否是其他页面中最好的。

要搭好路桥,我们要做的就是提高学生自营业务网站的内容质量,让搜索引擎蜘蛛在以用户为中心的基础上更好的被抓。

最后,如果你对SEO优化感兴趣,不了解网站optimization推广,私信回复“数据”,我会给你发送3.7G软件包和内部SEO优化课程让你进入SEO这条路可以少走一点弯路,哪怕只有一点 查看全部

彻底解决网站内容的收集和捕获要解决企业网站的收录问题

通过做网站,只有彻底解决网站的收录和抓取问题,才能最大化网站的价值,实现这样的网站内容不管数量还是质量。以上有待改进。 网站 结构对用户和蜘蛛都有利,因为蜘蛛和用户相辅相成。只有通过网站同时满足要求才是好的网站。

彻底解决网站内容的采集和抓取

解决企业网站的收录问题,首先要制定步骤,了解学生搜索引擎蜘蛛的工作方法。首先,蜘蛛需要到达你的网站,所以除了固定蜘蛛来的方式外,我们还可以主动引导他抓取我们的内容,如果没有抓到我们,我们可以主动提交给他。 (善用百度站长平台的主动提交、手动提交和站点地图)

彻底解决网站内容的采集和抓取

蜘蛛到达我们的网站。对于我们的国家,我们仍然需要让他高兴地抓住它。这涉及到网站主要内容的可识别性,下载页面设计能否顺利下载,产品信息页面是否描述清楚等等。

彻底解决网站内容的采集和抓取

蜘蛛抓取成功后,会将内容放入索引库中进行过滤比较,然后在用户搜索相关关键词时显示出来。索引就是我们通常所说的收录、收录,它只是表示你的页面存在于搜索引擎的索引库中,并不代表它被显示出来。

重要的是蜘蛛是否会抓取您的页面,是否会抓取高质量的页面,以及客户搜索关键字时您的页面是否是其他页面中最好的。

要搭好路桥,我们要做的就是提高学生自营业务网站的内容质量,让搜索引擎蜘蛛在以用户为中心的基础上更好的被抓。

最后,如果你对SEO优化感兴趣,不了解网站optimization推广,私信回复“数据”,我会给你发送3.7G软件包和内部SEO优化课程让你进入SEO这条路可以少走一点弯路,哪怕只有一点

网页里注释的内容会被百度抓取分析吗?(图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 152 次浏览 • 2021-06-28 05:54

很多站长都知道网页代码里有评论代码。形式是HTML中的注释内容出现在网页的源代码中,用户在浏览网页时是看不到的。因为源码中显示的注解内容不会影响页面的内容,很多人认为蜘蛛会抓取注解信息参与网页的分析和排名,所以添加了大量的注解内容到网页,甚至直接在注解里堆关键词。 .

网页上的评论内容会被抓取吗?我们来看看百度工程师是如何回答的:

问:评论内容会被百度抓取分析吗?

百度工程师:在文本提取过程中会忽略html中的评论内容。注释的代码虽然不会被爬取,但也会造成代码繁琐,所以可以尽量少。

显然,搜索引擎蜘蛛非常聪明。他们可以在网络爬虫过程中识别注释信息并直接忽略它。因此,注释内容不会被抓取,也不会参与网页内容的分析。进去试想一下,如果蜘蛛可以抓取评论,而这个评论代码就相当于一种隐藏的文字,那么网站主内容就可以被JS代码调用,只供用户浏览,把你想要的内容都放上去抓取的蜘蛛有大量的注释信息,使网页向蜘蛛和用户展示不同的内容。如果你是灰色行业网站,那么你可以给搜索引擎一个完全正规的内容展示,摆脱搜索引擎的束缚,搜索引擎会不会正式允许你作弊?所以不管你在评论里加多少关键词,都不会影响排名。

评论里加关键词会影响排名吗?不会是因为搜索引擎直接忽略了注释,而是如何注释大量内容会影响网页的风格,影响网页的加载速度。因此,如果注释没有用,请尝试删除它们并尽可能保持代码简单。我们经常谈论网站code 减肥。简化标注信息是减肥的方法之一。优化注解信息对网站瘦身有利。

当然,很多程序员和网页设计师都习惯于给网页添加注释信息。这是一个好习惯。合理的注解信息可以减少查找信息的时间,使代码的查询和修改更加方便,所以建议在线网页简单地添加注解信息,比如网页各部分的头尾注解,重要的内容部分注释等,离线备份网页可以更详细地添加每个部分的注释信息,方便技术人员浏览和修改,不仅有利于网页瘦身,而且不影响未来的网页修改。 查看全部

网页里注释的内容会被百度抓取分析吗?(图)

很多站长都知道网页代码里有评论代码。形式是HTML中的注释内容出现在网页的源代码中,用户在浏览网页时是看不到的。因为源码中显示的注解内容不会影响页面的内容,很多人认为蜘蛛会抓取注解信息参与网页的分析和排名,所以添加了大量的注解内容到网页,甚至直接在注解里堆关键词。 .

网页上的评论内容会被抓取吗?我们来看看百度工程师是如何回答的:

问:评论内容会被百度抓取分析吗?

百度工程师:在文本提取过程中会忽略html中的评论内容。注释的代码虽然不会被爬取,但也会造成代码繁琐,所以可以尽量少。

显然,搜索引擎蜘蛛非常聪明。他们可以在网络爬虫过程中识别注释信息并直接忽略它。因此,注释内容不会被抓取,也不会参与网页内容的分析。进去试想一下,如果蜘蛛可以抓取评论,而这个评论代码就相当于一种隐藏的文字,那么网站主内容就可以被JS代码调用,只供用户浏览,把你想要的内容都放上去抓取的蜘蛛有大量的注释信息,使网页向蜘蛛和用户展示不同的内容。如果你是灰色行业网站,那么你可以给搜索引擎一个完全正规的内容展示,摆脱搜索引擎的束缚,搜索引擎会不会正式允许你作弊?所以不管你在评论里加多少关键词,都不会影响排名。