实时抓取网页数据

实时抓取网页数据(如何把网站提供的网页数据转换成格式化的数据(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 257 次浏览 • 2022-03-08 16:07

2022全球C++与系统软件技术大会| 3月11-12日上海点击查看详情>>>

背景网页抓取

大数据时代,一切都要用数据说话,而大数据处理的过程一般需要经过以下几个步骤

首先要做的是获取数据并提取有效数据,为下一步分析做准备。

有各种数据来源。我以为我是个足球爱好者,世界杯快到了,所以我想提取欧洲联赛的数据进行分析。很多网站都提供了详细的足球数据,比如:

这些网站提供了详细的足球数据,但是为了进一步分析,我们希望数据以格式化的形式存储,那么如何将这些网站提供的网页数据转换成格式化数据呢?? 这使用了网页抓取技术。简单来说,Web Scraping就是从网站中提取信息,通常使用程序来模拟人们浏览网页的过程,发送http请求,从http响应中获取结果。

网页抓取注意事项

在抓取数据之前,请注意以下几点:

Python Web Scraping 相关库

Python 提供了一个非常方便的 Web Scraping 基础,具有许多支持库。这是一个小选择

当然,您不必使用 Python,也不必编写自己的代码。建议关注import.io

网页抓取代码

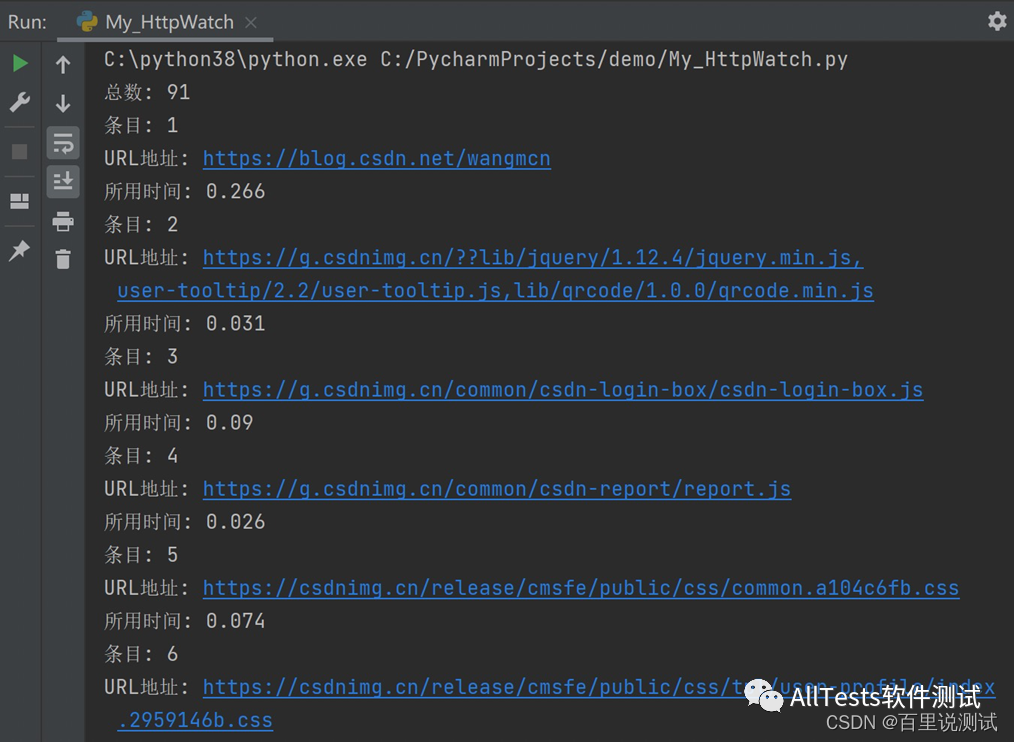

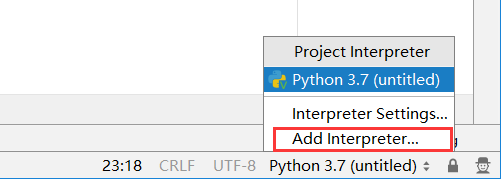

接下来,我们将一步步使用Python从腾讯体育抓取2013/14赛季欧洲联赛的数据。

首先安装 Beautifulsoup

pip install beautifulsoup4

让我们从玩家的数据开始。

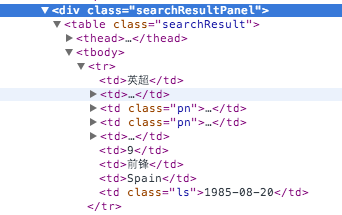

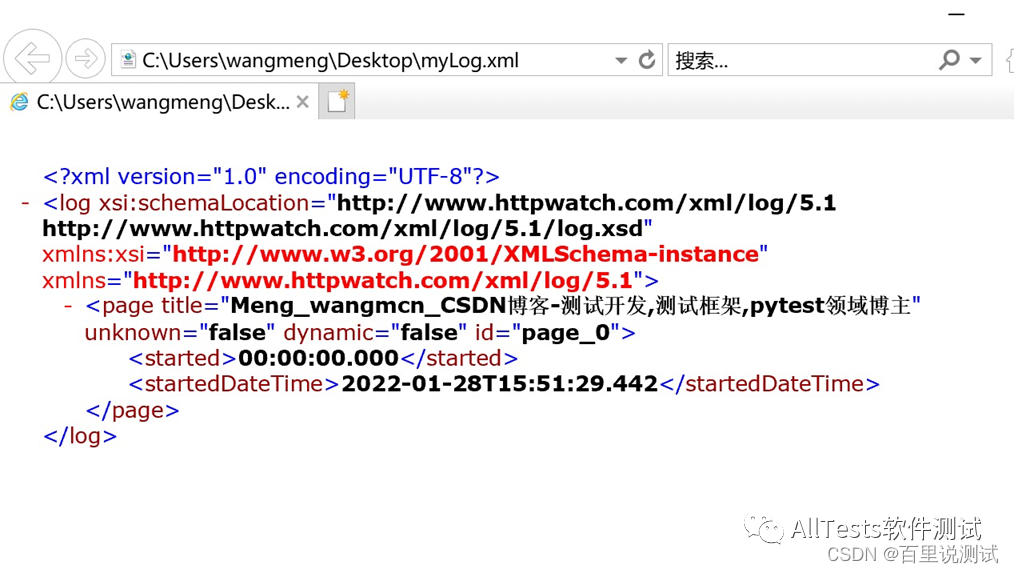

对玩家数据的网络请求是,返回的内容如下图所示:

web服务有两个参数,lega表示是哪个联赛,pn表示分页数。

首先,我们来做一些初始化准备

from urllib2 import urlopen

import urlparse

import bs4

BASE_URL = "http://soccerdata.sports.qq.com"

PLAYER_LIST_QUERY = "/playerSearch.aspx?lega=%s&pn=%d"

league = ['epl','seri','bund','liga','fran','scot','holl','belg']

page_number_limit = 100

player_fields = ['league_cn','img','name_cn','name','team','age','position_cn','nation','birth','query','id','teamid','league']

urlopen、urlparse、bs4 是我们将使用的 Python 库。

BASE_URL、PLAYER_LIST_QUERY、league、page_number_limit 和 player_fields 是我们将使用的一些常量。

下面是抓取玩家数据的具体代码:

def get_players(baseurl):

html = urlopen(baseurl).read()

soup = bs4.BeautifulSoup(html, "lxml")

players = [ dd for dd in soup.select('.searchResult tr') if dd.contents[1].name != 'th']

result = []

for player in players:

record = []

link = ''

query = []

for item in player.contents:

if type(item) is bs4.element.Tag:

if not item.string and item.img:

record.append(item.img['src'])

else :

record.append(item.string and item.string.strip() or 'na')

try:

o = urlparse.urlparse(item.a['href']).query

if len(link) == 0:

link = o

query = dict([(k,v[0]) for k,v in urlparse.parse_qs(o).items()])

except:

pass

if len(record) != 10:

for i in range(0, 10 - len(record)):

record.append('na')

record.append(unicode(link,'utf-8'))

record.append(unicode(query["id"],'utf-8'))

record.append(unicode(query["teamid"],'utf-8'))

record.append(unicode(query["lega"],'utf-8'))

result.append(record)

return result

result = []

for url in [ BASE_URL + PLAYER_LIST_QUERY % (l,n) for l in league for n in range(page_number_limit) ]:

result = result + get_players(url)

我们来看看抓取玩家数据的详细过程:

首先,我们定义一个 get_players 方法,该方法返回请求页面上所有玩家的数据。为了得到所有的数据,我们通过了一个for循环,因为我们要循环遍历每个联赛,每个联赛有多个页面。一般需要双循环:

for i in league:

for j in range(0, 100):

url = BASE_URL + PLAYER_LIST_QUERY % (l,n)

## send request to url and do scraping

Python 的列表推导可以通过构建列表轻松降低循环的级别。

此外,Python 有一个非常方便的合并连续列表的语法:list = list1 + list2

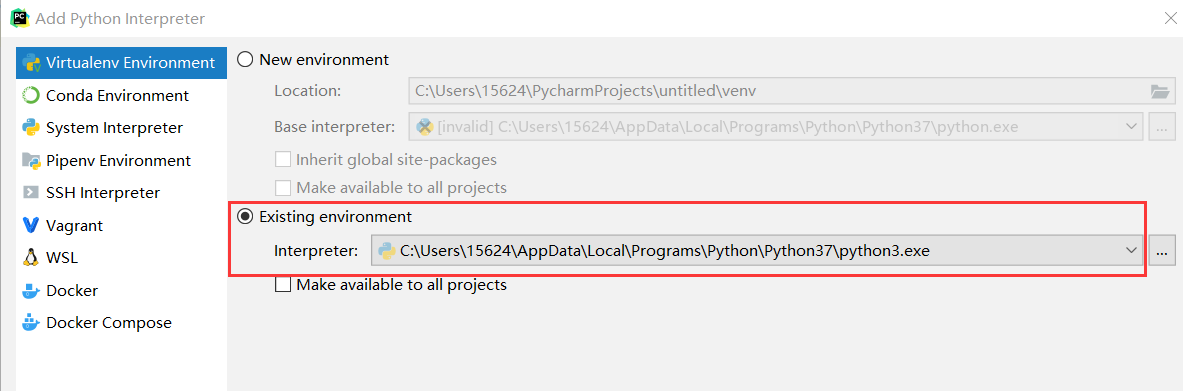

好,我们来看看如何使用BeautifulSoup来抓取网页中我们需要的内容。

首先调用urlopen读取对应url的内容,一般是html,用html构造一个beautifulsoup对象。

beautifulsoup 对象支持许多搜索功能,以及类似 css 的选择器。通常如果有一个 DOM 对象,我们使用下面的方式来查找它:

obj = soup.find("xx","cc")

另一种常用的方法是使用 CSS 选择器方法。在上面的代码中,我们选择了class=searchResult元素中的所有tr元素,过滤掉了th,也就是header元素。

for dd in soup.select('.searchResult tr') if dd.contents[1].name != 'th'

对于记录 tr 的每一行,都会生成一个玩家记录并将其存储在一个列表中。所以我们循环tr tr.contents 的内容来获取对应的字段内容。

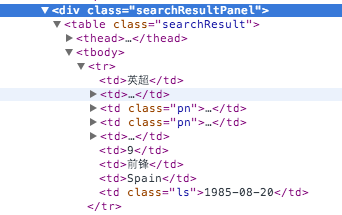

对于每个tr的内容,我们首先检查它的类型是否为Tag。Tag 类型有几种情况。一种是收录 img 的案例。我们需要取出玩家头像图片的URL。

另一种是收录指向其他数据内容的链接

所以这些不同的情况在代码中分别处理。

对于一个Tag 对象,Tag.x 可以得到它的子对象,Tag['x'] 可以得到Tag 的属性值。

所以使用 item.img['src'] 来获取 item 的子元素 img 的 src 属性。

对于已经收录链接的情况,我们使用urlparse来获取查询url中的参数。在这里,我们利用字典理解将查询参数放入字典,然后添加到列表中。

dict([(k,v[0]) for k,v in urlparse.parse_qs(o).items()])

对于其他情况,我们使用 Python 的 and or 表达式来保证当 Tag 的内容为空时,我们写 'na',类似于三元运算符 X ? A : B 在 C/C++ 或 Java 中

然后有一段代码判断当前记录的长度是否大于10,如果不大于10则用空值填充,以避免出现一些不一致的情况。

if len(record) != 10:

for i in range(0, 10 - len(record)):

record.append('na')

最后,我们在查询中添加一些相关参数,比如球员的id、球队的id、联赛代码等到列表中。

record.append(unicode(link,'utf-8'))

record.append(unicode(query["id"],'utf-8'))

record.append(unicode(query["teamid"],'utf-8'))

record.append(unicode(query["lega"],'utf-8'))

最后,我们把这个页面上所有玩家的列表放到一个列表中,然后返回。

好的,现在我们有了一个收录所有玩家信息的列表,我们需要保存它以供进一步处理、分析。通常,csv 格式是一种常见的选择。

import csv

def write_csv(filename, content, header = None):

file = open(filename, "wb")

file.write('\xEF\xBB\xBF')

writer = csv.writer(file, delimiter=',')

if header:

writer.writerow(header)

for row in content:

encoderow = [dd.encode('utf8') for dd in row]

writer.writerow(encoderow)

write_csv('players.csv',result,player_fields)

这里需要注意的是编码的问题。因为我们使用的是utf-8编码方式,所以在csv的文件头中,我们需要写\xEF\xBB\xBF,详见这篇文章文章

好了,现在大功告成,捕获的csv如下:

因为之前我们也抓取了本赛季球员的比赛详情,所以我们可以进一步抓取所有球员每场比赛的记录

抓取的代码如下

def get_player_match(url):

html = urlopen(url).read()

soup = bs4.BeautifulSoup(html, "lxml")

matches = [ dd for dd in soup.select('.shtdm tr') if dd.contents[1].name != 'th']

records = []

for item in [ dd for dd in matches if len(dd.contents) > 11]: ## filter out the personal part

record = []

for match in [ dd for dd in item.contents if type(dd) is bs4.element.Tag]:

if match.string:

record.append(match.string)

else:

for d in [ dd for dd in match.contents if type(dd) is bs4.element.Tag]:

query = dict([(k,v[0]) for k,v in urlparse.parse_qs(d['href']).items()])

record.append('teamid' in query and query['teamid'] or query['id'])

record.append(d.string and d.string or 'na')

records.append(record)

return records[1:] ##remove the first record as the header

def get_players_match(playerlist, baseurl = BASE_URL + '/player.aspx?'):

result = []

for item in playerlist:

url = baseurl + item[10]

print url

result = result + get_player_match(url)

return result

match_fields = ['date_cn','homeid','homename_cn','matchid','score','awayid','awayname_cn','league_cn','firstteam','playtime','goal','assist','shoot','run','corner','offside','foul','violation','yellowcard','redcard','save']

write_csv('m.csv',get_players_match(result),match_fields)

爬取过程与之前类似。

接下来做什么

既然我们已经有了详细的欧联杯数据,接下来我们应该怎么做呢?我建议您将数据导入 BI 工具以进行进一步分析。有两个更好的选择:

Tableau 在数据可视化领域是无与伦比的。Tableau Public 完全免费。它使用数据可视化来驱动数据探索和分析,具有非常好的用户体验。

Splunk 提供了一个大数据平台,主要针对机器数据。支持每天免费导入500M数据,个人学习应该够用了。

当然你也可以使用 Excel。另外,如果大家有什么好的免费数据分析平台,欢迎交流。 查看全部

实时抓取网页数据(如何把网站提供的网页数据转换成格式化的数据(图))

2022全球C++与系统软件技术大会| 3月11-12日上海点击查看详情>>>

背景网页抓取

大数据时代,一切都要用数据说话,而大数据处理的过程一般需要经过以下几个步骤

首先要做的是获取数据并提取有效数据,为下一步分析做准备。

有各种数据来源。我以为我是个足球爱好者,世界杯快到了,所以我想提取欧洲联赛的数据进行分析。很多网站都提供了详细的足球数据,比如:

这些网站提供了详细的足球数据,但是为了进一步分析,我们希望数据以格式化的形式存储,那么如何将这些网站提供的网页数据转换成格式化数据呢?? 这使用了网页抓取技术。简单来说,Web Scraping就是从网站中提取信息,通常使用程序来模拟人们浏览网页的过程,发送http请求,从http响应中获取结果。

网页抓取注意事项

在抓取数据之前,请注意以下几点:

Python Web Scraping 相关库

Python 提供了一个非常方便的 Web Scraping 基础,具有许多支持库。这是一个小选择

当然,您不必使用 Python,也不必编写自己的代码。建议关注import.io

网页抓取代码

接下来,我们将一步步使用Python从腾讯体育抓取2013/14赛季欧洲联赛的数据。

首先安装 Beautifulsoup

pip install beautifulsoup4

让我们从玩家的数据开始。

对玩家数据的网络请求是,返回的内容如下图所示:

web服务有两个参数,lega表示是哪个联赛,pn表示分页数。

首先,我们来做一些初始化准备

from urllib2 import urlopen

import urlparse

import bs4

BASE_URL = "http://soccerdata.sports.qq.com"

PLAYER_LIST_QUERY = "/playerSearch.aspx?lega=%s&pn=%d"

league = ['epl','seri','bund','liga','fran','scot','holl','belg']

page_number_limit = 100

player_fields = ['league_cn','img','name_cn','name','team','age','position_cn','nation','birth','query','id','teamid','league']

urlopen、urlparse、bs4 是我们将使用的 Python 库。

BASE_URL、PLAYER_LIST_QUERY、league、page_number_limit 和 player_fields 是我们将使用的一些常量。

下面是抓取玩家数据的具体代码:

def get_players(baseurl):

html = urlopen(baseurl).read()

soup = bs4.BeautifulSoup(html, "lxml")

players = [ dd for dd in soup.select('.searchResult tr') if dd.contents[1].name != 'th']

result = []

for player in players:

record = []

link = ''

query = []

for item in player.contents:

if type(item) is bs4.element.Tag:

if not item.string and item.img:

record.append(item.img['src'])

else :

record.append(item.string and item.string.strip() or 'na')

try:

o = urlparse.urlparse(item.a['href']).query

if len(link) == 0:

link = o

query = dict([(k,v[0]) for k,v in urlparse.parse_qs(o).items()])

except:

pass

if len(record) != 10:

for i in range(0, 10 - len(record)):

record.append('na')

record.append(unicode(link,'utf-8'))

record.append(unicode(query["id"],'utf-8'))

record.append(unicode(query["teamid"],'utf-8'))

record.append(unicode(query["lega"],'utf-8'))

result.append(record)

return result

result = []

for url in [ BASE_URL + PLAYER_LIST_QUERY % (l,n) for l in league for n in range(page_number_limit) ]:

result = result + get_players(url)

我们来看看抓取玩家数据的详细过程:

首先,我们定义一个 get_players 方法,该方法返回请求页面上所有玩家的数据。为了得到所有的数据,我们通过了一个for循环,因为我们要循环遍历每个联赛,每个联赛有多个页面。一般需要双循环:

for i in league:

for j in range(0, 100):

url = BASE_URL + PLAYER_LIST_QUERY % (l,n)

## send request to url and do scraping

Python 的列表推导可以通过构建列表轻松降低循环的级别。

此外,Python 有一个非常方便的合并连续列表的语法:list = list1 + list2

好,我们来看看如何使用BeautifulSoup来抓取网页中我们需要的内容。

首先调用urlopen读取对应url的内容,一般是html,用html构造一个beautifulsoup对象。

beautifulsoup 对象支持许多搜索功能,以及类似 css 的选择器。通常如果有一个 DOM 对象,我们使用下面的方式来查找它:

obj = soup.find("xx","cc")

另一种常用的方法是使用 CSS 选择器方法。在上面的代码中,我们选择了class=searchResult元素中的所有tr元素,过滤掉了th,也就是header元素。

for dd in soup.select('.searchResult tr') if dd.contents[1].name != 'th'

对于记录 tr 的每一行,都会生成一个玩家记录并将其存储在一个列表中。所以我们循环tr tr.contents 的内容来获取对应的字段内容。

对于每个tr的内容,我们首先检查它的类型是否为Tag。Tag 类型有几种情况。一种是收录 img 的案例。我们需要取出玩家头像图片的URL。

另一种是收录指向其他数据内容的链接

所以这些不同的情况在代码中分别处理。

对于一个Tag 对象,Tag.x 可以得到它的子对象,Tag['x'] 可以得到Tag 的属性值。

所以使用 item.img['src'] 来获取 item 的子元素 img 的 src 属性。

对于已经收录链接的情况,我们使用urlparse来获取查询url中的参数。在这里,我们利用字典理解将查询参数放入字典,然后添加到列表中。

dict([(k,v[0]) for k,v in urlparse.parse_qs(o).items()])

对于其他情况,我们使用 Python 的 and or 表达式来保证当 Tag 的内容为空时,我们写 'na',类似于三元运算符 X ? A : B 在 C/C++ 或 Java 中

然后有一段代码判断当前记录的长度是否大于10,如果不大于10则用空值填充,以避免出现一些不一致的情况。

if len(record) != 10:

for i in range(0, 10 - len(record)):

record.append('na')

最后,我们在查询中添加一些相关参数,比如球员的id、球队的id、联赛代码等到列表中。

record.append(unicode(link,'utf-8'))

record.append(unicode(query["id"],'utf-8'))

record.append(unicode(query["teamid"],'utf-8'))

record.append(unicode(query["lega"],'utf-8'))

最后,我们把这个页面上所有玩家的列表放到一个列表中,然后返回。

好的,现在我们有了一个收录所有玩家信息的列表,我们需要保存它以供进一步处理、分析。通常,csv 格式是一种常见的选择。

import csv

def write_csv(filename, content, header = None):

file = open(filename, "wb")

file.write('\xEF\xBB\xBF')

writer = csv.writer(file, delimiter=',')

if header:

writer.writerow(header)

for row in content:

encoderow = [dd.encode('utf8') for dd in row]

writer.writerow(encoderow)

write_csv('players.csv',result,player_fields)

这里需要注意的是编码的问题。因为我们使用的是utf-8编码方式,所以在csv的文件头中,我们需要写\xEF\xBB\xBF,详见这篇文章文章

好了,现在大功告成,捕获的csv如下:

因为之前我们也抓取了本赛季球员的比赛详情,所以我们可以进一步抓取所有球员每场比赛的记录

抓取的代码如下

def get_player_match(url):

html = urlopen(url).read()

soup = bs4.BeautifulSoup(html, "lxml")

matches = [ dd for dd in soup.select('.shtdm tr') if dd.contents[1].name != 'th']

records = []

for item in [ dd for dd in matches if len(dd.contents) > 11]: ## filter out the personal part

record = []

for match in [ dd for dd in item.contents if type(dd) is bs4.element.Tag]:

if match.string:

record.append(match.string)

else:

for d in [ dd for dd in match.contents if type(dd) is bs4.element.Tag]:

query = dict([(k,v[0]) for k,v in urlparse.parse_qs(d['href']).items()])

record.append('teamid' in query and query['teamid'] or query['id'])

record.append(d.string and d.string or 'na')

records.append(record)

return records[1:] ##remove the first record as the header

def get_players_match(playerlist, baseurl = BASE_URL + '/player.aspx?'):

result = []

for item in playerlist:

url = baseurl + item[10]

print url

result = result + get_player_match(url)

return result

match_fields = ['date_cn','homeid','homename_cn','matchid','score','awayid','awayname_cn','league_cn','firstteam','playtime','goal','assist','shoot','run','corner','offside','foul','violation','yellowcard','redcard','save']

write_csv('m.csv',get_players_match(result),match_fields)

爬取过程与之前类似。

接下来做什么

既然我们已经有了详细的欧联杯数据,接下来我们应该怎么做呢?我建议您将数据导入 BI 工具以进行进一步分析。有两个更好的选择:

Tableau 在数据可视化领域是无与伦比的。Tableau Public 完全免费。它使用数据可视化来驱动数据探索和分析,具有非常好的用户体验。

Splunk 提供了一个大数据平台,主要针对机器数据。支持每天免费导入500M数据,个人学习应该够用了。

当然你也可以使用 Excel。另外,如果大家有什么好的免费数据分析平台,欢迎交流。

实时抓取网页数据(一种基于管理大数据的仿真实训系统(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-03-07 11:00

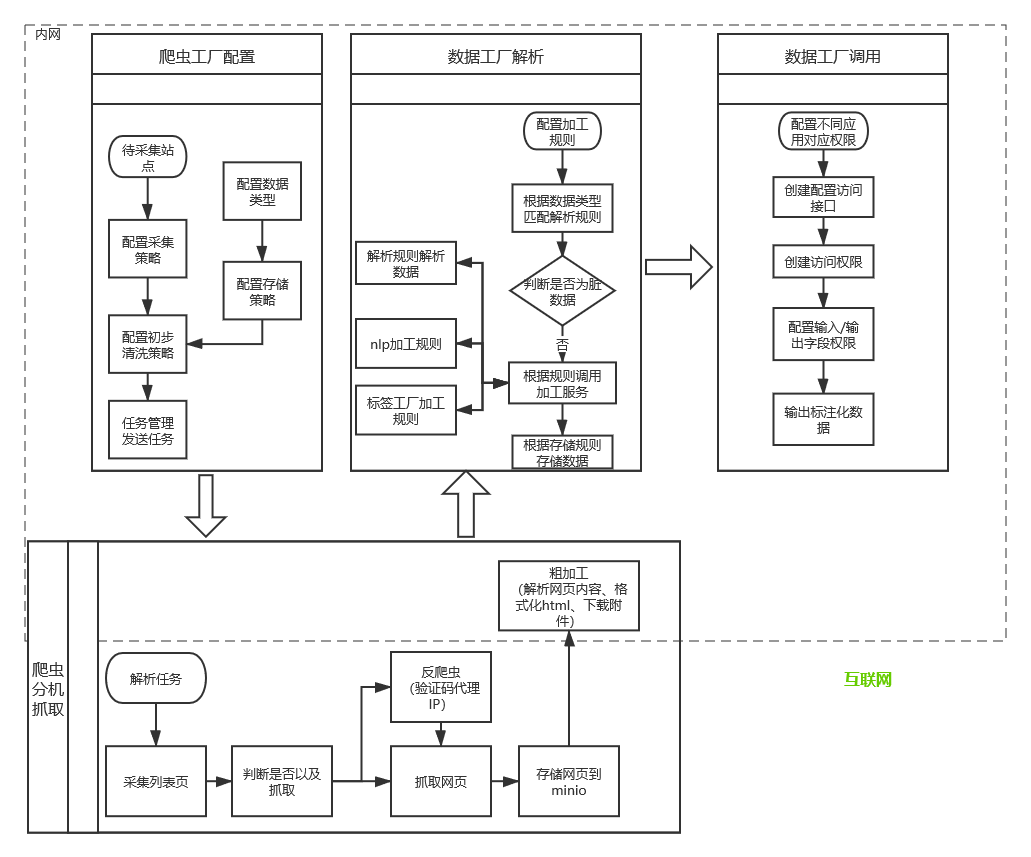

一种基于管理大数据的模拟训练系统,包括网络爬虫单元和信息处理单元、管理单元、信息同步处理单元、推送单元、信息接收单元、训练单元、信息获取处理单元、网络爬虫单元和信息单元处理单元和管理单元是安装在管理者PC中的应用软件。信息同步处理单元、推送单元、信息接收单元、培训单元是安装在管理者培训系统中的应用软件。信息采集处理单元安装在管理端教学老师PC端应用软件和手机APP端。在实际使用本发明专利技术时,网络爬虫单元实时抓取互联网上与专业培训相关的网页内容,管理单元将培训系统分为简单、困难、难的。互动交流,针对培训过程中出现的问题,实时向学员提出合理化建议,从而提高学员的培训效果。

下载所有详细的技术数据

【技术实现步骤总结】

基于管理大数据的模拟培训系统

该专利技术涉及互联网应用

,尤其是基于管理大数据的模拟训练系统。

技术介绍

在教育领域,模拟训练是指利用多媒体、模拟、虚拟现实等技术,在计算机上创造出能够辅助、部分替代甚至完全替代传统实训科目的技术。以同样的方式完成各种学习训练科目,所获得的学习训练效果等同于甚至优于在真实环境中获得的效果,有助于提高教学质量。现有的教学模拟实训系统一般是在固定科目下进行,科目的后续更新需要通过互联网或其他渠道手动采集信息,然后制作和更新科目;而教学人员只能当场更新培训人员。在实际使用中非常不方便。网络爬虫是一种自动提取网页的程序。它从万维网上为搜索引擎下载网页。它是搜索引擎的重要组成部分。并建立索引供后续查询检索;对于重点爬虫来说,这个过程中得到的分析结果也可以对后续的爬取过程提供反馈和指导。在此基础上,提供了一种利用网络爬虫在互联网上实时抓取本专业相关网页的方法,为该专业后续培训科目的更新提供强有力的数据支持,音频可以将培训人员的视频和视频传输给远程教学人员。,

技术实现思路

为克服现有教育领域模拟培训系统的不足,专利技术提供使用网络爬虫实时抓取互联网上专业培训的相关网页内容,让专业可为后续管理人员快速、快捷地实施培训科目。此次更新提供了强有力的数据支持,丰富了培训科目。管理单位根据培训科目的难易程度将培训体系分为简单、困难和困难三个等级。培训单位可以根据培训人员的培训效果,对每个分数给出合理化建议,使培训人员得到循序渐进的培训,取得良好的培训效果。而且,培训人员在培训中的音视频信息可以通过信息处理单元通过互联网实时传送给远程教学人员。,使远程管理人员能够实时掌握培训人员的培训过程,针对培训过程中出现的问题,实时为培训人员提出合理的建议,从而提高培训人员的培训效果. 一种基于管理大数据的仿真训练系统。该专利技术解决其技术问题所采用的技术方案是:一种基于管理大数据的模拟训练系统,其特点是包括网络爬虫单元、信息处理单元、管理单元、信息同步处理单元、推送单元、信息处理单元和信息处理单元。接收单元、训练单元、信息获取处理单元、网络爬虫单元、信息处理单元和管理单元是安装在管理PC中的应用软件。信息同步处理单元、推送单元、信息接收单元、培训单元是安装在管理培训系统中的应用软件,信息采集处理单元是安装在管理教师PC、APP中的应用软件在手机中,网络爬虫单元实时抓取并存储互联网上与专业培训相关的网络内容。, 信息处理单元进一步对网络爬虫单元实时抓取的网页内容进行细化、分类、处理和存储,以便后续管理人员通过管理单元通过相关网页快速查询专业培训软件的各项信息。互联网上本专业的各种适用培训软件,以及各种培训软件的各种信息,以及从网络上检索到的各种适用培训软件和自行开发的培训软件,根据需要进行更新和存储。训练科目的难度将训练系统分为三个层次。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。培训单元根据信息接收单元接收到的培训科目进行培训。在培训作业中,信息同步处理单元对培训人员的音视频数据和培训效果数据进行处理,通过推送单元将各种数据通过互联网传输,推送单元安装在管理教师的PC中,信息采集在管理教师的PC中。手机处理单元接收

网络爬虫单元实时抓取并存储互联网上专业培训的相关网页内容,以方便专业人士通过网页实时获取专业培训技术的发展情况,尽快获得专业的公众使用和良好的效果。培训软件的直接使用,以及培训软件的获取方式,尽快为培训软件的开发提供各种数据支持。信息处理单元根据专业模拟技术的开发,最新的免费培训软件,对网络爬虫单元实时抓取的网页内容进行进一步细化、分类、处理和存储,最新培训软件的获取方法,培训软件的相关技术。分类存储,方便管理人员及时查看相关网页信息。管理单位在互联网上采集本专业的各类适用培训软件,以及各类培训软件的各种信息,并根据需要进行从网络上采集的各类适用培训软件和自行开发的培训软件。更新存储,根据训练科目的难易程度将训练系统分为简单、困难、困难三个等级。每个级别又细分为初级子级、中级子级和高级子级。训练单元根据信息接收单元接收到的训练对象进行训练操作。培训单位在培训人员时,可以根据每次培训人员的实际培训成绩给出合理化建议。当分数高时,它会发出输入下一个培训计划的音频和视频建议。当分数低时,会发出维持当前训练计划的音视频建议。当分数很低时,会发出返回上一个培训计划的音视频建议,让学员得到一个循序渐进的培训计划。训练取得好成绩。可根据每次培训人员的实际培训成绩给出合理化建议。当分数高时,它会发出输入下一个培训计划的音频和视频建议。当分数低时,会发出维持当前训练计划的音视频建议。当分数很低时,会发出返回上一个培训计划的音视频建议,让学员得到一个循序渐进的培训计划。训练取得好成绩。可根据每次培训人员的实际培训成绩给出合理化建议。当分数高时,它会发出输入下一个培训计划的音频和视频建议。当分数低时,会发出维持当前训练计划的音视频建议。当分数很低时,会发出返回上一个培训计划的音视频建议,让学员得到一个循序渐进的培训计划。训练取得好成绩。当分数很低时,会发出返回上一个培训计划的音视频建议,让学员得到一个循序渐进的培训计划。训练取得好成绩。当分数很低时,会发出返回上一个培训计划的音视频建议,让学员得到一个循序渐进的培训计划。训练取得好成绩。

信息同步处理单元对培训人员的音视频数据和培训效果数据进行处理,通过推送单元通过互联网传输各种数据,安装在管理教师PC和手机中的信息采集处理单元中. 收到推送单元推送的数据后,可以向培训人员提出合理的建议。信息采集处理单元可以将接收到的多个学生的训练数据分屏显示,并可以同时与多个学生进行音视频交互。提高学员的培训效果。专利技术的有益效果是:在专利技术的实际使用中,管理方利用网络爬虫单元实时抓取互联网上专业培训的相关网页内容,为后续管理方快速更新培训科目提供了有力的数据支持,丰富了培训的难度。培训科目,管理单位将培训体系分为简单、困难、困难三个层次,并进一步细分为初级子级、中级子级和高级子级。高水平培训人员提供不同培训级别的培训科目,满足各级培训人员的培训需求;在培训过程中,培训单位可以根据培训人员每次的培训效果,给出合理的建议,使培训得到提高。培训师可以得到分步培训,达到良好的培训效果,培训师在培训中的音视频信息和培训成绩信息可以通过信息同步处理单元通过信息同步处理单元实时传送给远程教学人员。互联网。人员收到数据后,可以实时掌握培训人员的培训过程,并可以与培训人员进行互动,针对培训过程中出现的问题,实时给培训人员合理化建议,从而提高培训人员的培训效果。培训人员在培训中的音视频信息和培训成绩信息可以通过信息同步处理单元通过互联网实时传送给远程教学人员。人员收到数据后,可以实时掌握培训人员的培训过程,并可以与培训人员进行互动,针对培训过程中出现的问题,实时给培训人员合理化建议,从而提高培训人员的培训效果。培训人员在培训中的音视频信息和培训成绩信息可以通过信息同步处理单元通过互联网实时传送给远程教学人员。人员收到数据后,可以实时掌握培训人员的培训过程,并可以与培训人员进行互动,针对培训过程中出现的问题,实时给培训人员合理化建议,从而提高培训人员的培训效果。

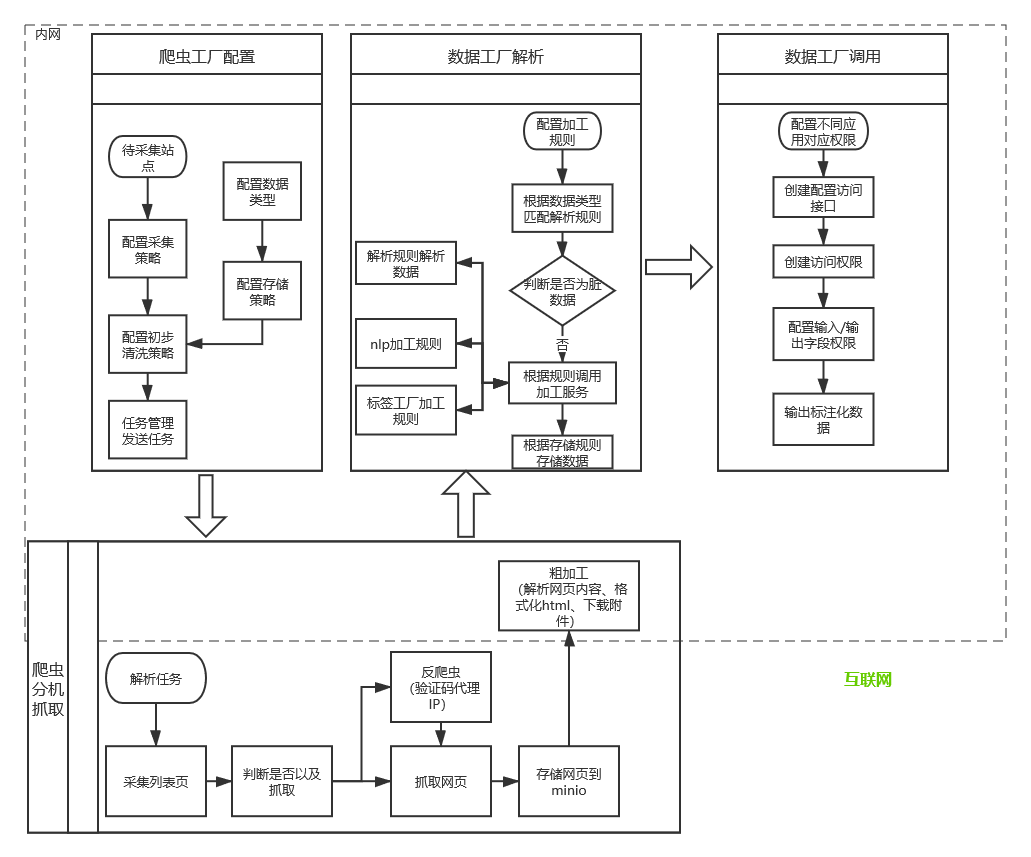

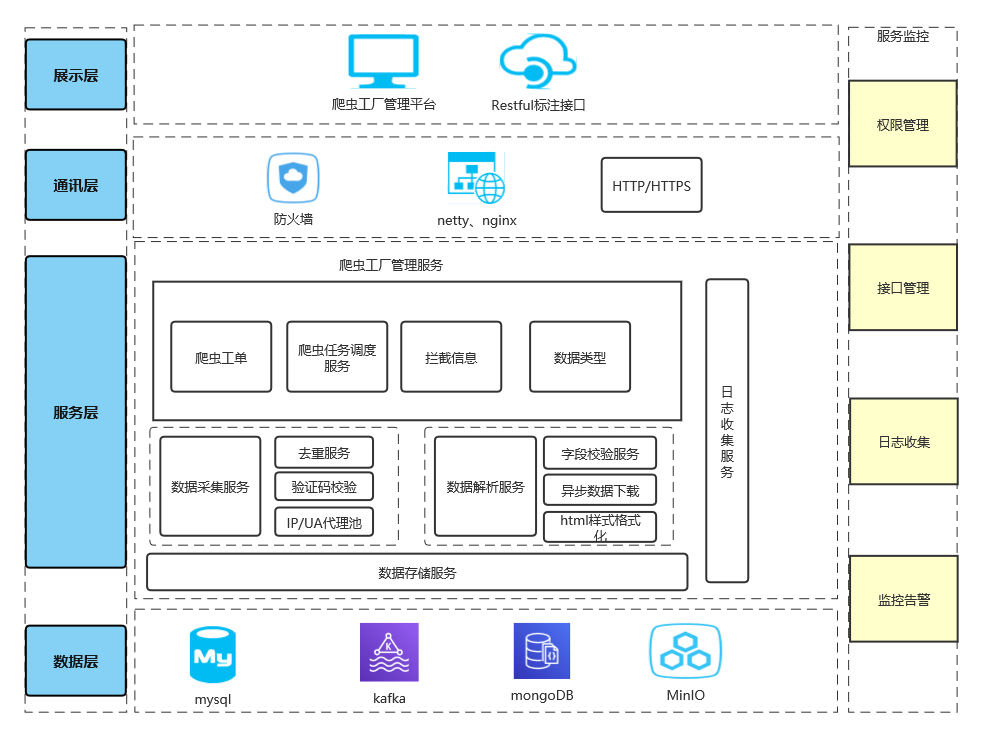

综上所述,该专利技术具有良好的应用前景。附图说明下面结合附图和实施例对本专利技术作进一步说明。图1为本专利技术架构框图。如图1所示,一种基于管理大数据的模拟训练系统,包括网络爬虫单元、信息处理单元、管理单元、信息同步处理单元、推送单元、信息接收单元、训练单元、信息处理单元. 获取处理单元、网络爬虫单元、信息处理单元和管理单元是安装在管理PC中的应用软件。信息同步处理单元、推送单元、信息接收单元、培训单元是安装在管理培训系统中的应用程序。软件,信息采集处理单元是安装在管理教师PC上的应用软件,手机中的APP。网络爬虫单元实时抓取互联网上与专业培训相关的网络内容并存储。信息处理单元负责网络爬虫单元。对实时抓取的网页内容进行进一步细化、分类、处理和存储,以便后续管理人员通过管理单元及时通过相关网页快速查询专业培训软件的各项信息。培训软件,以及各种培训软件的各种信息,并根据需要,根据培训科目的难易程度,对从网络上采集的各种适用培训软件和自行开发的培训软件进行更新和存储。培训体系分为三个层次。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。训练单元根据信息接收单元接收到的训练科目进行训练操作,信息同步进行。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。训练单元根据信息接收单元接收到的训练科目进行训练操作,信息同步进行。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。训练单元根据信息接收单元接收到的训练科目进行训练操作,信息同步进行。

【技术保护点】

1.一种基于管理大数据的模拟训练系统,其特征在于包括网络爬虫单元、信息处理单元、管理单元、信息同步处理单元、推送单元、信息接收单元、训练单元和信息获取单元。处理单元、网络爬虫单元、信息处理单元和管理单元是安装在管理PC中的应用软件。信息同步处理单元、推送单元、信息接收单元和培训单元是安装在管理培训系统中的应用软件。,信息采集处理单元是安装在管理教师PC上的应用软件,手机中的APP。网络爬虫单元实时抓取并存储互联网上与专业培训相关的网页内容。信息处理单元实时监控网络爬虫单元。对抓取的网页内容进行进一步细化、分类、处理和存储,以便后续管理人员通过管理单元及时通过相关网页快速查询到专业培训软件的各项信息。培训软件,以及各种培训软件的各种信息,根据需要,更新和存储从网络采集的各种适用培训软件和自行开发的培训软件,根据培训科目的难易程度,培训系统分为三个水平。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。培训单元根据信息接收单元接收到的培训科目进行培训作业,信息同步处理单元对学员的音视频数据和培训效果数据进行处理,通过网络推送各种数据单元,安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。培训单元根据信息接收单元接收到的培训科目进行培训作业,信息同步处理单元对学员的音视频数据和培训效果数据进行处理,通过网络推送各种数据单元,安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。培训单元根据信息接收单元接收到的培训科目进行培训作业,信息同步处理单元对学员的音视频数据和培训效果数据进行处理,通过网络推送各种数据单元,安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。

【技术特点总结】

1.一种基于管理大数据的模拟训练系统,其特征在于包括网络爬虫单元、信息处理单元、管理单元、信息同步处理单元、推送单元、信息接收单元、训练单元和信息获取单元。处理单元、网络爬虫单元、信息处理单元和管理单元是安装在管理PC中的应用软件。信息同步处理单元、推送单元、信息接收单元和培训单元是安装在管理培训系统中的应用软件。,信息采集处理单元是安装在管理教师PC上的应用软件,手机中的APP。网络爬虫单元实时抓取并存储互联网上与专业培训相关的网页内容。信息处理单元实时监控网络爬虫单元。对抓取的网页内容进行进一步细化、分类、处理和存储,以便后续管理人员通过管理单元及时通过相关网页快速查询到专业培训软件的各项信息。培训软件,以及各种培训软件的各种信息,根据需要,根据培训科目的难易程度,更新和存储从网络上检索到的各种适用培训软件和自行开发的培训软件。培训体系分为三个层次。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。培训单元根据信息接收单元接收到的培训科目进行培训操作,信息同步处理单元对学员的音视频数据和培训效果数据进行处理,通过网络推送各种数据单元,安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。2.根据权利要求1所述的一种基于管理大数据的模拟训练系统,

【专利技术性质】

技术研发人员:蔡立煌,

申请人(专利权)持有人:蔡立煌,

类型:发明

国家、省、市:福建,35

下载所有详细的技术数据 我是该专利的所有者 查看全部

实时抓取网页数据(一种基于管理大数据的仿真实训系统(组图))

一种基于管理大数据的模拟训练系统,包括网络爬虫单元和信息处理单元、管理单元、信息同步处理单元、推送单元、信息接收单元、训练单元、信息获取处理单元、网络爬虫单元和信息单元处理单元和管理单元是安装在管理者PC中的应用软件。信息同步处理单元、推送单元、信息接收单元、培训单元是安装在管理者培训系统中的应用软件。信息采集处理单元安装在管理端教学老师PC端应用软件和手机APP端。在实际使用本发明专利技术时,网络爬虫单元实时抓取互联网上与专业培训相关的网页内容,管理单元将培训系统分为简单、困难、难的。互动交流,针对培训过程中出现的问题,实时向学员提出合理化建议,从而提高学员的培训效果。

下载所有详细的技术数据

【技术实现步骤总结】

基于管理大数据的模拟培训系统

该专利技术涉及互联网应用

,尤其是基于管理大数据的模拟训练系统。

技术介绍

在教育领域,模拟训练是指利用多媒体、模拟、虚拟现实等技术,在计算机上创造出能够辅助、部分替代甚至完全替代传统实训科目的技术。以同样的方式完成各种学习训练科目,所获得的学习训练效果等同于甚至优于在真实环境中获得的效果,有助于提高教学质量。现有的教学模拟实训系统一般是在固定科目下进行,科目的后续更新需要通过互联网或其他渠道手动采集信息,然后制作和更新科目;而教学人员只能当场更新培训人员。在实际使用中非常不方便。网络爬虫是一种自动提取网页的程序。它从万维网上为搜索引擎下载网页。它是搜索引擎的重要组成部分。并建立索引供后续查询检索;对于重点爬虫来说,这个过程中得到的分析结果也可以对后续的爬取过程提供反馈和指导。在此基础上,提供了一种利用网络爬虫在互联网上实时抓取本专业相关网页的方法,为该专业后续培训科目的更新提供强有力的数据支持,音频可以将培训人员的视频和视频传输给远程教学人员。,

技术实现思路

为克服现有教育领域模拟培训系统的不足,专利技术提供使用网络爬虫实时抓取互联网上专业培训的相关网页内容,让专业可为后续管理人员快速、快捷地实施培训科目。此次更新提供了强有力的数据支持,丰富了培训科目。管理单位根据培训科目的难易程度将培训体系分为简单、困难和困难三个等级。培训单位可以根据培训人员的培训效果,对每个分数给出合理化建议,使培训人员得到循序渐进的培训,取得良好的培训效果。而且,培训人员在培训中的音视频信息可以通过信息处理单元通过互联网实时传送给远程教学人员。,使远程管理人员能够实时掌握培训人员的培训过程,针对培训过程中出现的问题,实时为培训人员提出合理的建议,从而提高培训人员的培训效果. 一种基于管理大数据的仿真训练系统。该专利技术解决其技术问题所采用的技术方案是:一种基于管理大数据的模拟训练系统,其特点是包括网络爬虫单元、信息处理单元、管理单元、信息同步处理单元、推送单元、信息处理单元和信息处理单元。接收单元、训练单元、信息获取处理单元、网络爬虫单元、信息处理单元和管理单元是安装在管理PC中的应用软件。信息同步处理单元、推送单元、信息接收单元、培训单元是安装在管理培训系统中的应用软件,信息采集处理单元是安装在管理教师PC、APP中的应用软件在手机中,网络爬虫单元实时抓取并存储互联网上与专业培训相关的网络内容。, 信息处理单元进一步对网络爬虫单元实时抓取的网页内容进行细化、分类、处理和存储,以便后续管理人员通过管理单元通过相关网页快速查询专业培训软件的各项信息。互联网上本专业的各种适用培训软件,以及各种培训软件的各种信息,以及从网络上检索到的各种适用培训软件和自行开发的培训软件,根据需要进行更新和存储。训练科目的难度将训练系统分为三个层次。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。培训单元根据信息接收单元接收到的培训科目进行培训。在培训作业中,信息同步处理单元对培训人员的音视频数据和培训效果数据进行处理,通过推送单元将各种数据通过互联网传输,推送单元安装在管理教师的PC中,信息采集在管理教师的PC中。手机处理单元接收

网络爬虫单元实时抓取并存储互联网上专业培训的相关网页内容,以方便专业人士通过网页实时获取专业培训技术的发展情况,尽快获得专业的公众使用和良好的效果。培训软件的直接使用,以及培训软件的获取方式,尽快为培训软件的开发提供各种数据支持。信息处理单元根据专业模拟技术的开发,最新的免费培训软件,对网络爬虫单元实时抓取的网页内容进行进一步细化、分类、处理和存储,最新培训软件的获取方法,培训软件的相关技术。分类存储,方便管理人员及时查看相关网页信息。管理单位在互联网上采集本专业的各类适用培训软件,以及各类培训软件的各种信息,并根据需要进行从网络上采集的各类适用培训软件和自行开发的培训软件。更新存储,根据训练科目的难易程度将训练系统分为简单、困难、困难三个等级。每个级别又细分为初级子级、中级子级和高级子级。训练单元根据信息接收单元接收到的训练对象进行训练操作。培训单位在培训人员时,可以根据每次培训人员的实际培训成绩给出合理化建议。当分数高时,它会发出输入下一个培训计划的音频和视频建议。当分数低时,会发出维持当前训练计划的音视频建议。当分数很低时,会发出返回上一个培训计划的音视频建议,让学员得到一个循序渐进的培训计划。训练取得好成绩。可根据每次培训人员的实际培训成绩给出合理化建议。当分数高时,它会发出输入下一个培训计划的音频和视频建议。当分数低时,会发出维持当前训练计划的音视频建议。当分数很低时,会发出返回上一个培训计划的音视频建议,让学员得到一个循序渐进的培训计划。训练取得好成绩。可根据每次培训人员的实际培训成绩给出合理化建议。当分数高时,它会发出输入下一个培训计划的音频和视频建议。当分数低时,会发出维持当前训练计划的音视频建议。当分数很低时,会发出返回上一个培训计划的音视频建议,让学员得到一个循序渐进的培训计划。训练取得好成绩。当分数很低时,会发出返回上一个培训计划的音视频建议,让学员得到一个循序渐进的培训计划。训练取得好成绩。当分数很低时,会发出返回上一个培训计划的音视频建议,让学员得到一个循序渐进的培训计划。训练取得好成绩。

信息同步处理单元对培训人员的音视频数据和培训效果数据进行处理,通过推送单元通过互联网传输各种数据,安装在管理教师PC和手机中的信息采集处理单元中. 收到推送单元推送的数据后,可以向培训人员提出合理的建议。信息采集处理单元可以将接收到的多个学生的训练数据分屏显示,并可以同时与多个学生进行音视频交互。提高学员的培训效果。专利技术的有益效果是:在专利技术的实际使用中,管理方利用网络爬虫单元实时抓取互联网上专业培训的相关网页内容,为后续管理方快速更新培训科目提供了有力的数据支持,丰富了培训的难度。培训科目,管理单位将培训体系分为简单、困难、困难三个层次,并进一步细分为初级子级、中级子级和高级子级。高水平培训人员提供不同培训级别的培训科目,满足各级培训人员的培训需求;在培训过程中,培训单位可以根据培训人员每次的培训效果,给出合理的建议,使培训得到提高。培训师可以得到分步培训,达到良好的培训效果,培训师在培训中的音视频信息和培训成绩信息可以通过信息同步处理单元通过信息同步处理单元实时传送给远程教学人员。互联网。人员收到数据后,可以实时掌握培训人员的培训过程,并可以与培训人员进行互动,针对培训过程中出现的问题,实时给培训人员合理化建议,从而提高培训人员的培训效果。培训人员在培训中的音视频信息和培训成绩信息可以通过信息同步处理单元通过互联网实时传送给远程教学人员。人员收到数据后,可以实时掌握培训人员的培训过程,并可以与培训人员进行互动,针对培训过程中出现的问题,实时给培训人员合理化建议,从而提高培训人员的培训效果。培训人员在培训中的音视频信息和培训成绩信息可以通过信息同步处理单元通过互联网实时传送给远程教学人员。人员收到数据后,可以实时掌握培训人员的培训过程,并可以与培训人员进行互动,针对培训过程中出现的问题,实时给培训人员合理化建议,从而提高培训人员的培训效果。

综上所述,该专利技术具有良好的应用前景。附图说明下面结合附图和实施例对本专利技术作进一步说明。图1为本专利技术架构框图。如图1所示,一种基于管理大数据的模拟训练系统,包括网络爬虫单元、信息处理单元、管理单元、信息同步处理单元、推送单元、信息接收单元、训练单元、信息处理单元. 获取处理单元、网络爬虫单元、信息处理单元和管理单元是安装在管理PC中的应用软件。信息同步处理单元、推送单元、信息接收单元、培训单元是安装在管理培训系统中的应用程序。软件,信息采集处理单元是安装在管理教师PC上的应用软件,手机中的APP。网络爬虫单元实时抓取互联网上与专业培训相关的网络内容并存储。信息处理单元负责网络爬虫单元。对实时抓取的网页内容进行进一步细化、分类、处理和存储,以便后续管理人员通过管理单元及时通过相关网页快速查询专业培训软件的各项信息。培训软件,以及各种培训软件的各种信息,并根据需要,根据培训科目的难易程度,对从网络上采集的各种适用培训软件和自行开发的培训软件进行更新和存储。培训体系分为三个层次。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。训练单元根据信息接收单元接收到的训练科目进行训练操作,信息同步进行。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。训练单元根据信息接收单元接收到的训练科目进行训练操作,信息同步进行。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。训练单元根据信息接收单元接收到的训练科目进行训练操作,信息同步进行。

【技术保护点】

1.一种基于管理大数据的模拟训练系统,其特征在于包括网络爬虫单元、信息处理单元、管理单元、信息同步处理单元、推送单元、信息接收单元、训练单元和信息获取单元。处理单元、网络爬虫单元、信息处理单元和管理单元是安装在管理PC中的应用软件。信息同步处理单元、推送单元、信息接收单元和培训单元是安装在管理培训系统中的应用软件。,信息采集处理单元是安装在管理教师PC上的应用软件,手机中的APP。网络爬虫单元实时抓取并存储互联网上与专业培训相关的网页内容。信息处理单元实时监控网络爬虫单元。对抓取的网页内容进行进一步细化、分类、处理和存储,以便后续管理人员通过管理单元及时通过相关网页快速查询到专业培训软件的各项信息。培训软件,以及各种培训软件的各种信息,根据需要,更新和存储从网络采集的各种适用培训软件和自行开发的培训软件,根据培训科目的难易程度,培训系统分为三个水平。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。培训单元根据信息接收单元接收到的培训科目进行培训作业,信息同步处理单元对学员的音视频数据和培训效果数据进行处理,通过网络推送各种数据单元,安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。培训单元根据信息接收单元接收到的培训科目进行培训作业,信息同步处理单元对学员的音视频数据和培训效果数据进行处理,通过网络推送各种数据单元,安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。培训单元根据信息接收单元接收到的培训科目进行培训作业,信息同步处理单元对学员的音视频数据和培训效果数据进行处理,通过网络推送各种数据单元,安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。

【技术特点总结】

1.一种基于管理大数据的模拟训练系统,其特征在于包括网络爬虫单元、信息处理单元、管理单元、信息同步处理单元、推送单元、信息接收单元、训练单元和信息获取单元。处理单元、网络爬虫单元、信息处理单元和管理单元是安装在管理PC中的应用软件。信息同步处理单元、推送单元、信息接收单元和培训单元是安装在管理培训系统中的应用软件。,信息采集处理单元是安装在管理教师PC上的应用软件,手机中的APP。网络爬虫单元实时抓取并存储互联网上与专业培训相关的网页内容。信息处理单元实时监控网络爬虫单元。对抓取的网页内容进行进一步细化、分类、处理和存储,以便后续管理人员通过管理单元及时通过相关网页快速查询到专业培训软件的各项信息。培训软件,以及各种培训软件的各种信息,根据需要,根据培训科目的难易程度,更新和存储从网络上检索到的各种适用培训软件和自行开发的培训软件。培训体系分为三个层次。管理单元通过互联网将信息发送到安装在管理培训系统中的信息接收单元。培训单元根据信息接收单元接收到的培训科目进行培训操作,信息同步处理单元对学员的音视频数据和培训效果数据进行处理,通过网络推送各种数据单元,安装在管理教师PC和手机中的信息采集处理单元接收推送单元推送的数据。之后,它可以向学员提出合理的建议。2.根据权利要求1所述的一种基于管理大数据的模拟训练系统,

【专利技术性质】

技术研发人员:蔡立煌,

申请人(专利权)持有人:蔡立煌,

类型:发明

国家、省、市:福建,35

下载所有详细的技术数据 我是该专利的所有者

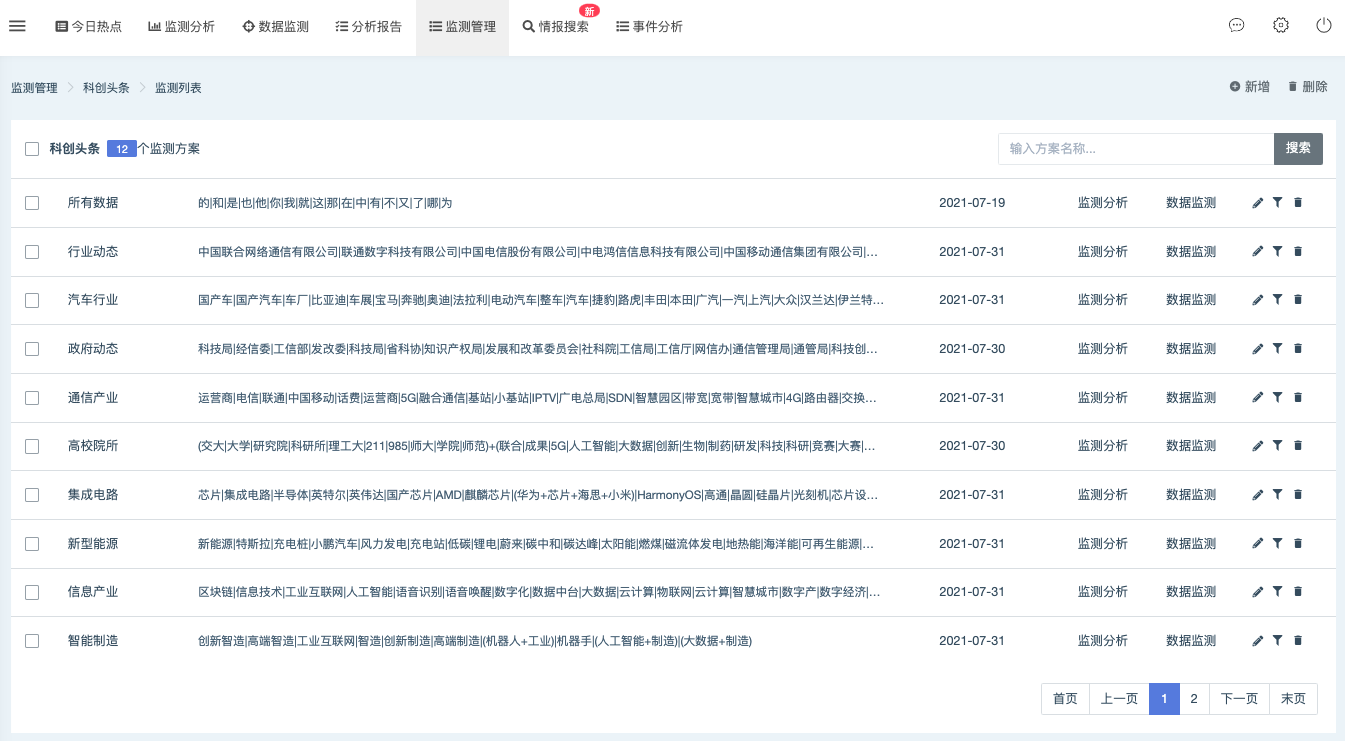

实时抓取网页数据(监控网站可以设置不同的监控频率吗?-八维教育)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-03-07 10:24

如果您需要监控采集招标采购信息;或者需要关注采集财经新闻;或需要监控采集招生招生内容;或者需要监控采集舆情内容。请继续阅读,目标是及时发现网站更新,在极短的时间内完成数据自动化采集。

由于每个网站内容格式不同,需要有针对性的自定义数据采集方案。

1、实时监控更新及采集内容原理:首先,在监控主机上运行网站信息监控软件,添加要监控的URL来监控网站主页或栏目列表页为主。发现更新后,立即向 采集 主持人发送更新的新闻标题和链接。采集主机收到新闻链接后,会自动用木头浏览器打开网页,采集新闻标题和正文内容,然后存入数据库或导出Excel文件,或填写表格并提交到其他系统。监控主机和采集主机可以部署在不同的计算机上,也可以部署在同一台计算机上,通过网络接口传输数据。

2、首先在监控主机上部署网站信息监控软件,添加要监控的URL,选择监控网站首页或者栏目页面。只要可以直接监控超链接列表格式的网页,其他特殊格式的页面需要添加相应的监控方案。每个监控网站可以设置不同的监控频率,对实时性要求高的网站可以设置高频监控。以各自的频率同时监控多个独立于 URL 的线程。您还可以通过 关键词 过滤无效内容。具体参数设置请参考软件手册和案例教程。

3、在监控和告警选项卡中,勾选“发送链接到外网接口”,并设置接收方的ip地址和端口号,这里是采集主机的ip地址127.@ >0.0.1,监听8888端口。当监听到任何网站更新时,会发出更新的内容和链接。

4、在采集主机上打开wood浏览器,选择“自动控制”菜单,打开“外部接口”,在弹出的外部接口窗口中,设置监听端口号为8888 . 设置接收数据时执行的指定自动控制工程文件。如果同时接收到多条数据,软件还可以按照设定的时间间隔依次处理每条数据。勾选“程序启动时自动开始监听”,这样只要浏览器启动,就可以在不打开外部接口表单的情况下接收数据。

5、打开浏览器的项目管理器来创建一个自动化项目。首先新建一个步骤,打开一个网页,在输入URL的控件中右键,选择外部变量@link,即从监控主机接收到的数据中的链接参数。执行项目时会自动打开此内容 URL。

6、创建一个元素监控步骤来监控内容页面的标题。通过标题内容,可以解读出内容来自哪个网站,然后跳转执行对应的数据采集步骤。这相当于编程中的多条件语句。其中,选择跳转步骤需要先完成本文第7步,再返回修改。

7、创建信息抓取步骤,从网页抓取标题和正文内容。将以变量的形式保存在软件中。以相同的方式创建每个 网站 数据抓取步骤和抓取内容参数。在这里,还可以添加分析过滤信息内容,判断不必要的无关内容,终止采集并保存。

8、如果要将采集的内容保存到数据库,可以创建“执行SQL”步骤,设置数据库连接参数,支持mssql、mysql、oracle、sqlite等数据库. 输入插入拼接sql语句,通过右键菜单将title和body变量插入到sql语句中。项目执行时,变量被替换,内容直接保存到数据库中。

9、如何将采集的数据保存到Excel表格文件,创建“保存数据”步骤,选择保存为Excel格式,输入保存路径和文件名,点击设置内容按钮,可以选择要保存的文件变量,这里可以选择标题和文字。

10、如果需要添加采集的内容,填写表格添加到其他系统,新建步骤打开网页,添加本系统的URL(登录步骤此处省略),并打开向系统添加数据的表单。

11、创建填写内容的步骤,在表单对应的输入框中填写内容。首先获取输入框元素,填写内容框并单击鼠标右键选择要输入的变量。

12、填写表格,添加点击提交按钮的步骤,这样采集的内容就添加到了新系统中。

从监控数据更新,到采集数据,保存到数据库或添加到其他系统,整个过程可以在无人值守的状态下,在极短的时间内自动快速完成。并且监控和采集软件可以放在后台运行,不影响电脑正常使用做其他工作。 查看全部

实时抓取网页数据(监控网站可以设置不同的监控频率吗?-八维教育)

如果您需要监控采集招标采购信息;或者需要关注采集财经新闻;或需要监控采集招生招生内容;或者需要监控采集舆情内容。请继续阅读,目标是及时发现网站更新,在极短的时间内完成数据自动化采集。

由于每个网站内容格式不同,需要有针对性的自定义数据采集方案。

1、实时监控更新及采集内容原理:首先,在监控主机上运行网站信息监控软件,添加要监控的URL来监控网站主页或栏目列表页为主。发现更新后,立即向 采集 主持人发送更新的新闻标题和链接。采集主机收到新闻链接后,会自动用木头浏览器打开网页,采集新闻标题和正文内容,然后存入数据库或导出Excel文件,或填写表格并提交到其他系统。监控主机和采集主机可以部署在不同的计算机上,也可以部署在同一台计算机上,通过网络接口传输数据。

2、首先在监控主机上部署网站信息监控软件,添加要监控的URL,选择监控网站首页或者栏目页面。只要可以直接监控超链接列表格式的网页,其他特殊格式的页面需要添加相应的监控方案。每个监控网站可以设置不同的监控频率,对实时性要求高的网站可以设置高频监控。以各自的频率同时监控多个独立于 URL 的线程。您还可以通过 关键词 过滤无效内容。具体参数设置请参考软件手册和案例教程。

3、在监控和告警选项卡中,勾选“发送链接到外网接口”,并设置接收方的ip地址和端口号,这里是采集主机的ip地址127.@ >0.0.1,监听8888端口。当监听到任何网站更新时,会发出更新的内容和链接。

4、在采集主机上打开wood浏览器,选择“自动控制”菜单,打开“外部接口”,在弹出的外部接口窗口中,设置监听端口号为8888 . 设置接收数据时执行的指定自动控制工程文件。如果同时接收到多条数据,软件还可以按照设定的时间间隔依次处理每条数据。勾选“程序启动时自动开始监听”,这样只要浏览器启动,就可以在不打开外部接口表单的情况下接收数据。

5、打开浏览器的项目管理器来创建一个自动化项目。首先新建一个步骤,打开一个网页,在输入URL的控件中右键,选择外部变量@link,即从监控主机接收到的数据中的链接参数。执行项目时会自动打开此内容 URL。

6、创建一个元素监控步骤来监控内容页面的标题。通过标题内容,可以解读出内容来自哪个网站,然后跳转执行对应的数据采集步骤。这相当于编程中的多条件语句。其中,选择跳转步骤需要先完成本文第7步,再返回修改。

7、创建信息抓取步骤,从网页抓取标题和正文内容。将以变量的形式保存在软件中。以相同的方式创建每个 网站 数据抓取步骤和抓取内容参数。在这里,还可以添加分析过滤信息内容,判断不必要的无关内容,终止采集并保存。

8、如果要将采集的内容保存到数据库,可以创建“执行SQL”步骤,设置数据库连接参数,支持mssql、mysql、oracle、sqlite等数据库. 输入插入拼接sql语句,通过右键菜单将title和body变量插入到sql语句中。项目执行时,变量被替换,内容直接保存到数据库中。

9、如何将采集的数据保存到Excel表格文件,创建“保存数据”步骤,选择保存为Excel格式,输入保存路径和文件名,点击设置内容按钮,可以选择要保存的文件变量,这里可以选择标题和文字。

10、如果需要添加采集的内容,填写表格添加到其他系统,新建步骤打开网页,添加本系统的URL(登录步骤此处省略),并打开向系统添加数据的表单。

11、创建填写内容的步骤,在表单对应的输入框中填写内容。首先获取输入框元素,填写内容框并单击鼠标右键选择要输入的变量。

12、填写表格,添加点击提交按钮的步骤,这样采集的内容就添加到了新系统中。

从监控数据更新,到采集数据,保存到数据库或添加到其他系统,整个过程可以在无人值守的状态下,在极短的时间内自动快速完成。并且监控和采集软件可以放在后台运行,不影响电脑正常使用做其他工作。

实时抓取网页数据(怎么用飞飞CMS采集让关键词排名以及网站快速收录?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2022-03-05 01:09

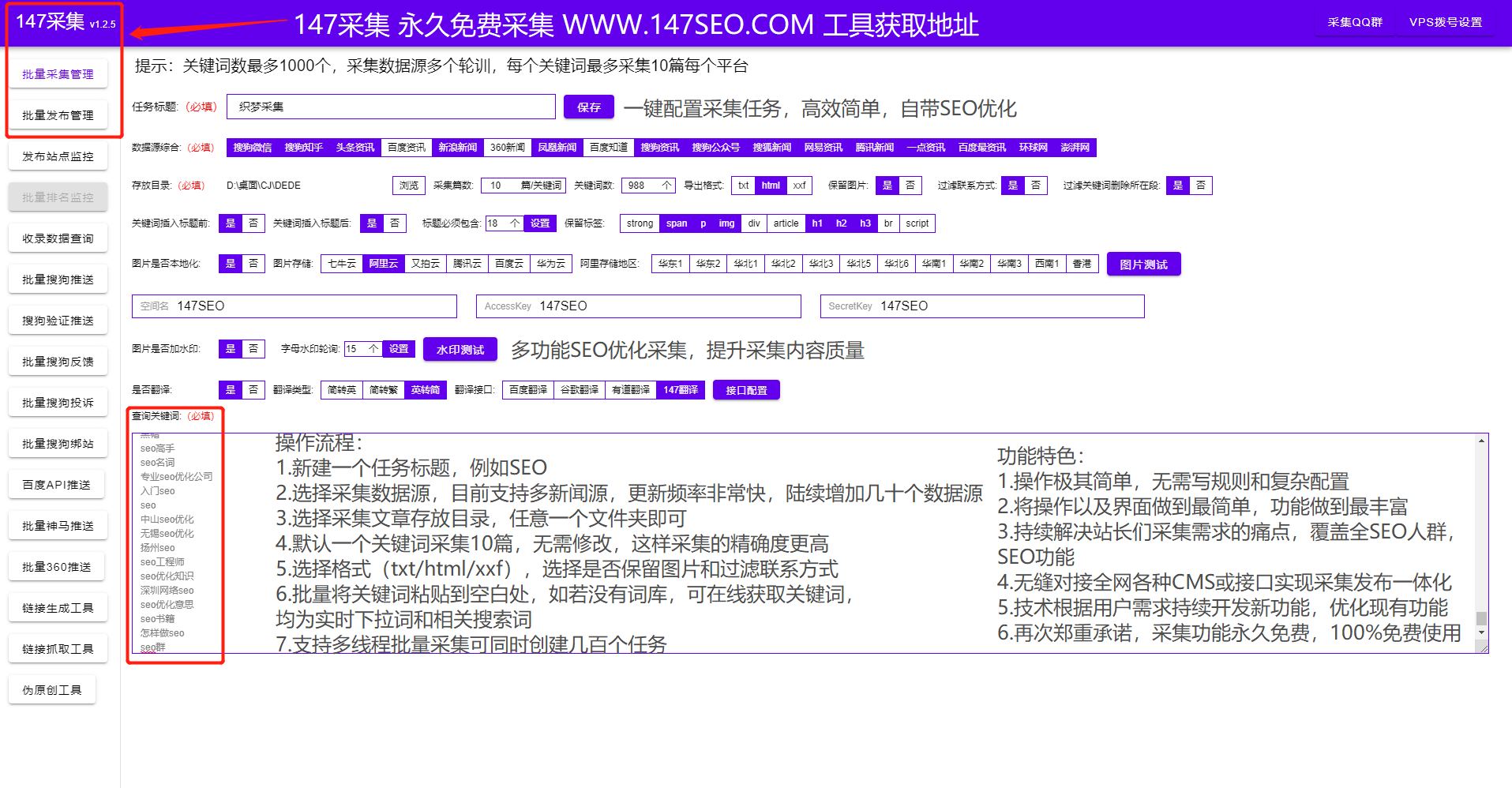

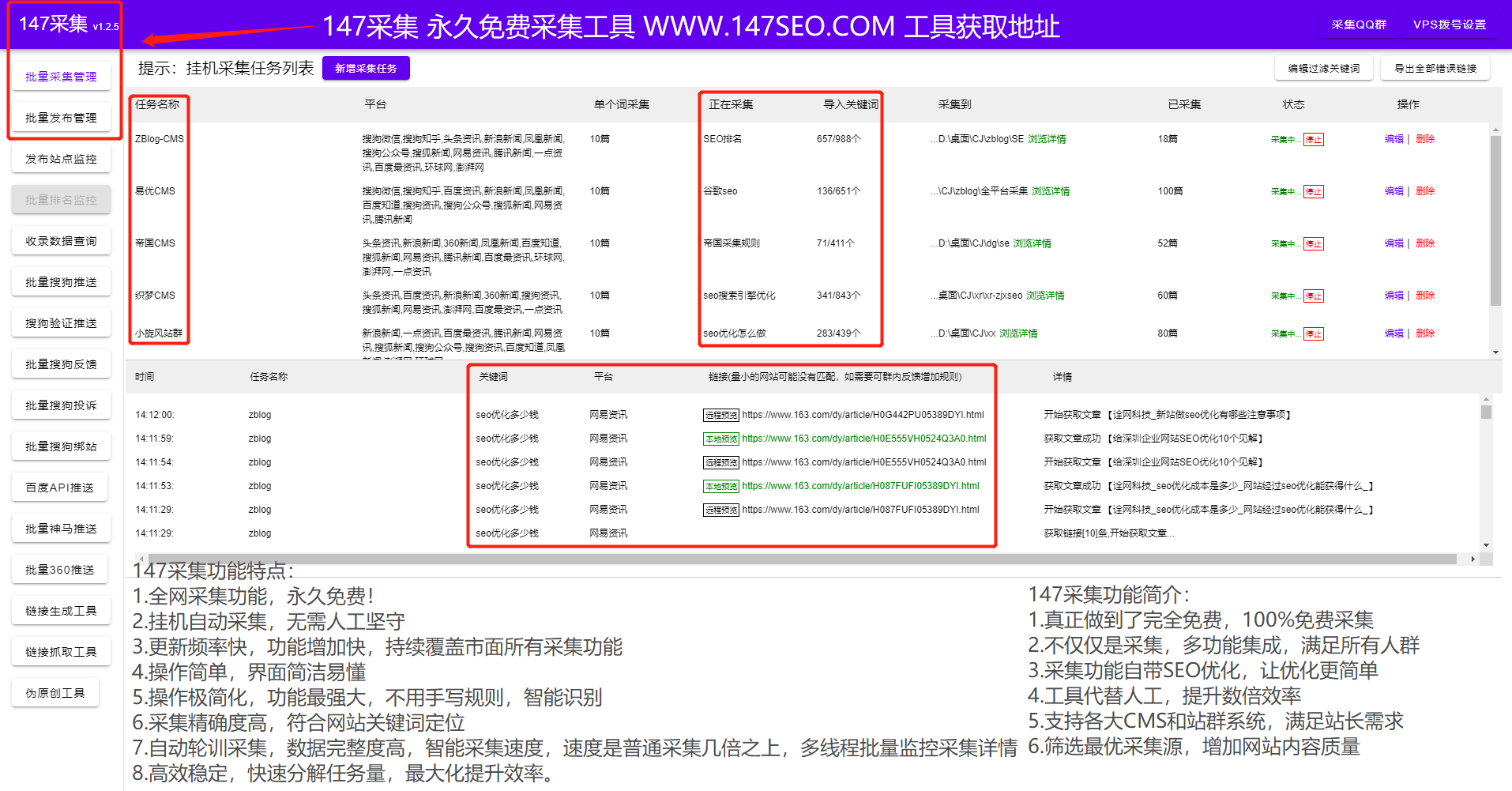

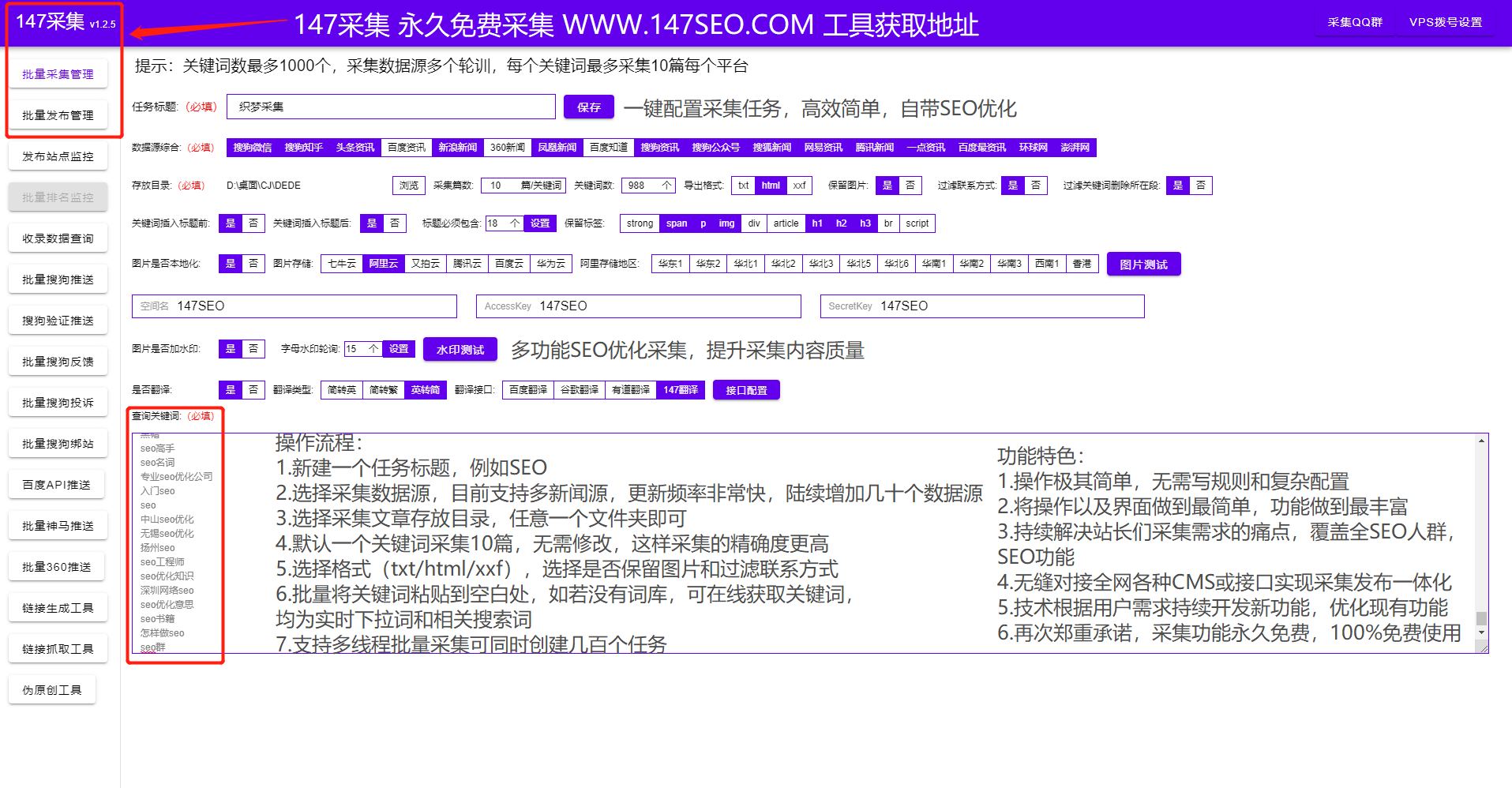

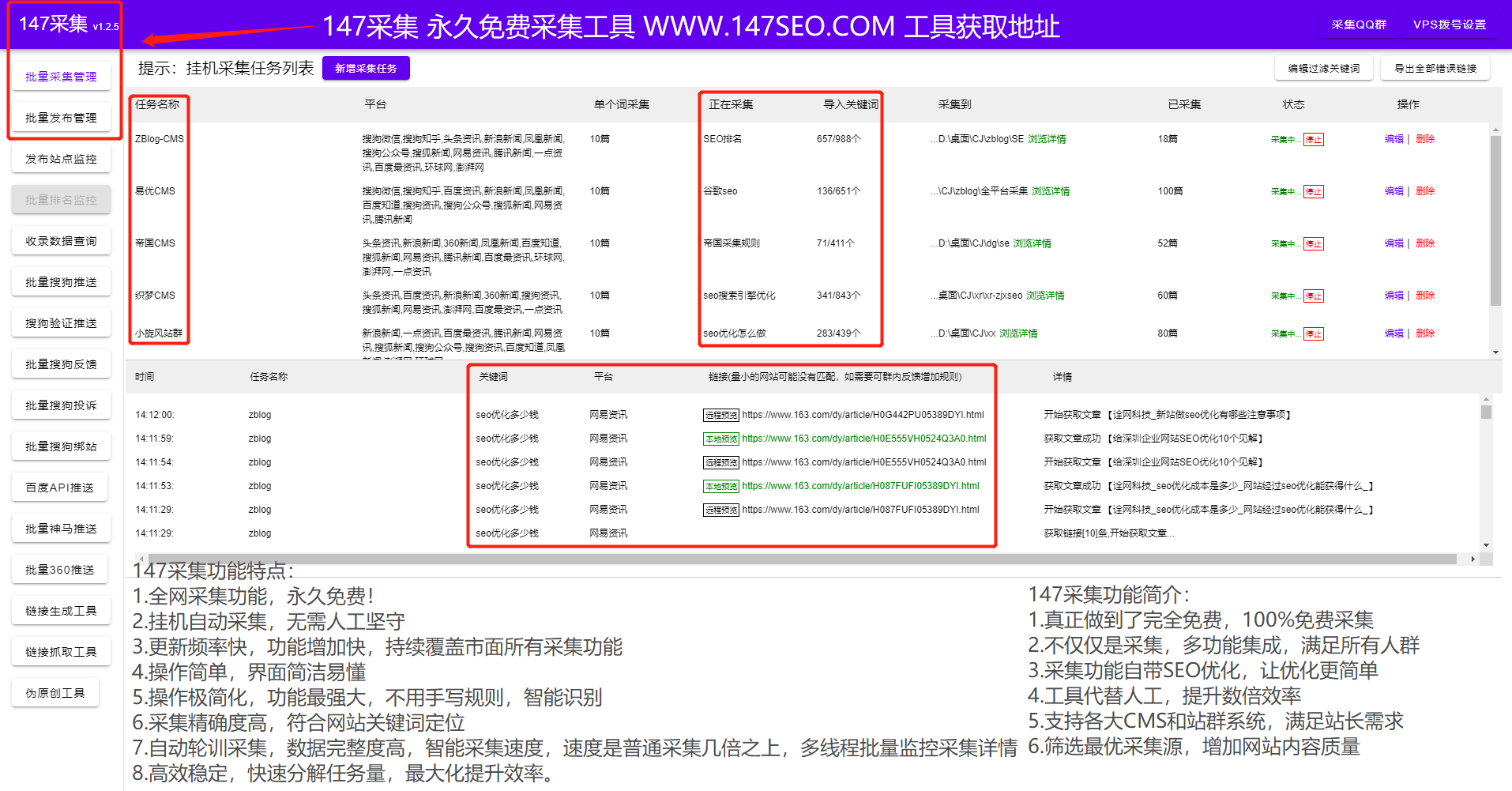

如何使用飞飞cms采集让关键词排名和网站快收录,相信很多朋友的网站排名都有经历了天堂和地狱......百度在近端时间波动很大,很多网站排名被PASS直接掉了。很多人对百度的调整一无所知,只能等待恢复正常。虽然目前还没有百度推出新算法的迹象,但作为SEO优化者,我们还是要根据目前的百度算法体系来调整优化网站,否则波动不能怪“大环境”。今天给大家分享一个可以批量管理网站的飞飞cms采集工具。不管你有成百上千个不同的飞飞cms< @网站或其他网站,可以实现统一管理。一个人维护数百个 网站文章 更新也不是问题。

一、菲菲cms已发表

1、批量监控管理不同的cms网站数据(你的网站是Empire, Yiyou, ZBLOG, 织梦, WP, Yunyoucms@ >、人人展cms、飞飞cms、Cyclone、站群、PBoot、Apple、Mito、搜外等主要cms,可批量管理采集伪原创,同时发布和推送工具)

2、设置批量发布次数(可以设置发布间隔/单日总发布次数)

3、不同关键词文章可设置发布不同栏目

4、伪原创保留字(当文章原创未被伪原创使用时设置核心字)

5、软件直接监控是否已发布、即将发布、是否为伪原创、发布状态、网址、节目、发布时间等。

6、每日蜘蛛、收录、网站权重可以通过软件直接查看

二、飞飞cms批量发布设置-覆盖SEO功能

本次飞飞cms版本还配备了很多SEO功能,不仅通过飞飞cms版本实现采集伪原创版本主动推送到搜索引擎,而且还有很多SEO方面的功能。可以提高页面的关键词密度和原创,增加用户体验,实现优质内容。

1、标题前缀和后缀设置(标题区分更好收录)

2、内容关键词插入(合理增加关键词的密度)

3、随机图片插入(文章如果没有图片可以随机插入相关图片)

4、搜索引擎推送(文章发布成功后,主动向搜索引擎推送文章,保证新链接能被搜索引擎及时推送收录)

5、随机点赞-随机阅读-随机作者(增加页面度数原创)

6、内容与标题一致(使内容与标题一致)

7、自动内链(发布任务时会在文章的内容中自动生成内链,帮助引导页面蜘蛛抓取,提高页面权限)

8、定期发布(定期发布网站内容可以让搜索引擎养成定期爬取网页的习惯,从而提升网站的收录)

三、飞飞cms采集

1、通过 Feifeicms采集 填充内容,根据 关键词采集文章。(飞飞cms采集插件也配置了关键词采集功能和无关词拦截功能)

2、自动过滤其他网站促销信息/支持其他网站信息替换

3、支持多种采集来源采集(涵盖所有行业新闻来源,内容库海量每天都有新内容,采集新内容)

4、支持其他平台的图片本地化或存储

5、自动批量挂机采集伪原创自动发布推送到搜索引擎

四、飞飞cms采集

1、查看采集平台

2、工作中采集

3、有采集

4、采集内容视图

查看5、采集之后的内容

五、飞飞cms伪原创:伪原创的意思是重新处理一个原创的文章,让搜索引擎认为它是一篇文章原创文章,从而增加了网站的权重。飞飞cms伪原创是为搜索引擎开发的伪原创。对于搜索引擎,它是 原创。当我们使用飞飞的cms插件维护好网站的时候,接下来我们面临的就是网站自身导致关键词排名波动的因素。

1、 网站排名的自然波动

网站关键词排名不是恒定的,即使每天优化,排名也会有一定的波动。这是正常现象。但是如果关键词的排名一直在上下,那么网站的收视率就比较不稳定,需要对网站的问题进行诊断再调整。

2、 竞争对手

在我们 网站 进行优化的同时,其他节点 网站 也在运行。有多种SEO优化方法。如果别人比我们的网站优化更好,那么搜索引擎也会把我们同行的网站放在我们的网站排名之上,网站的排名会波动。因此,SEO优化是一个长期且不可阻挡的过程。需要不断学习新的SEO优化技巧和方法来保持网站的竞争力。

3、 具体时间和热点

<p>尤其是飞飞cms网站很容易在某个时间、某个热点增加流量,所以有时候排名平平,但是在某个时间段,搜索的人比较多,而 查看全部

实时抓取网页数据(怎么用飞飞CMS采集让关键词排名以及网站快速收录?)

如何使用飞飞cms采集让关键词排名和网站快收录,相信很多朋友的网站排名都有经历了天堂和地狱......百度在近端时间波动很大,很多网站排名被PASS直接掉了。很多人对百度的调整一无所知,只能等待恢复正常。虽然目前还没有百度推出新算法的迹象,但作为SEO优化者,我们还是要根据目前的百度算法体系来调整优化网站,否则波动不能怪“大环境”。今天给大家分享一个可以批量管理网站的飞飞cms采集工具。不管你有成百上千个不同的飞飞cms< @网站或其他网站,可以实现统一管理。一个人维护数百个 网站文章 更新也不是问题。

一、菲菲cms已发表

1、批量监控管理不同的cms网站数据(你的网站是Empire, Yiyou, ZBLOG, 织梦, WP, Yunyoucms@ >、人人展cms、飞飞cms、Cyclone、站群、PBoot、Apple、Mito、搜外等主要cms,可批量管理采集伪原创,同时发布和推送工具)

2、设置批量发布次数(可以设置发布间隔/单日总发布次数)

3、不同关键词文章可设置发布不同栏目

4、伪原创保留字(当文章原创未被伪原创使用时设置核心字)

5、软件直接监控是否已发布、即将发布、是否为伪原创、发布状态、网址、节目、发布时间等。

6、每日蜘蛛、收录、网站权重可以通过软件直接查看

二、飞飞cms批量发布设置-覆盖SEO功能

本次飞飞cms版本还配备了很多SEO功能,不仅通过飞飞cms版本实现采集伪原创版本主动推送到搜索引擎,而且还有很多SEO方面的功能。可以提高页面的关键词密度和原创,增加用户体验,实现优质内容。

1、标题前缀和后缀设置(标题区分更好收录)

2、内容关键词插入(合理增加关键词的密度)

3、随机图片插入(文章如果没有图片可以随机插入相关图片)

4、搜索引擎推送(文章发布成功后,主动向搜索引擎推送文章,保证新链接能被搜索引擎及时推送收录)

5、随机点赞-随机阅读-随机作者(增加页面度数原创)

6、内容与标题一致(使内容与标题一致)

7、自动内链(发布任务时会在文章的内容中自动生成内链,帮助引导页面蜘蛛抓取,提高页面权限)

8、定期发布(定期发布网站内容可以让搜索引擎养成定期爬取网页的习惯,从而提升网站的收录)

三、飞飞cms采集

1、通过 Feifeicms采集 填充内容,根据 关键词采集文章。(飞飞cms采集插件也配置了关键词采集功能和无关词拦截功能)

2、自动过滤其他网站促销信息/支持其他网站信息替换

3、支持多种采集来源采集(涵盖所有行业新闻来源,内容库海量每天都有新内容,采集新内容)

4、支持其他平台的图片本地化或存储

5、自动批量挂机采集伪原创自动发布推送到搜索引擎

四、飞飞cms采集

1、查看采集平台

2、工作中采集

3、有采集

4、采集内容视图

查看5、采集之后的内容

五、飞飞cms伪原创:伪原创的意思是重新处理一个原创的文章,让搜索引擎认为它是一篇文章原创文章,从而增加了网站的权重。飞飞cms伪原创是为搜索引擎开发的伪原创。对于搜索引擎,它是 原创。当我们使用飞飞的cms插件维护好网站的时候,接下来我们面临的就是网站自身导致关键词排名波动的因素。

1、 网站排名的自然波动

网站关键词排名不是恒定的,即使每天优化,排名也会有一定的波动。这是正常现象。但是如果关键词的排名一直在上下,那么网站的收视率就比较不稳定,需要对网站的问题进行诊断再调整。

2、 竞争对手

在我们 网站 进行优化的同时,其他节点 网站 也在运行。有多种SEO优化方法。如果别人比我们的网站优化更好,那么搜索引擎也会把我们同行的网站放在我们的网站排名之上,网站的排名会波动。因此,SEO优化是一个长期且不可阻挡的过程。需要不断学习新的SEO优化技巧和方法来保持网站的竞争力。

3、 具体时间和热点

<p>尤其是飞飞cms网站很容易在某个时间、某个热点增加流量,所以有时候排名平平,但是在某个时间段,搜索的人比较多,而

实时抓取网页数据(废话如何知道你写的爬虫有没有正常运行,请求了多少个网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 252 次浏览 • 2022-03-04 17:18

效果图:

废话

怎么知道自己写的爬虫是否正常运行,运行了多长时间,请求了多少网页,抓取了多少条数据?官方其实提供了一个收录一些爬取相关信息的字典:crawler.stats.get_stats(),crawler是scrapy中的一个组件。您可以在许多组件中访问它,例如所有收录 from_crawler(cls, crawler) 方法的组件。

既然可以获取scrapy的运行状态,那么实时显示应该很简单。我们还使用了上一篇博客中使用的influxdb+grafana来展示数据。我们只需要将一些scrapy的操作信息实时同步到influxdb数据库中,然后我们就可以通过grafana将数据库的内容以图形的形式展示出来。

写数据库

如何将字典实时同步到数据库?必须在此处设置同步间隔,例如 5 秒。那么我们的要求就是让scrapy每隔5秒将爬虫的运行状态信息写入数据库。如上所述,可以访问 crawler.stats.get_stats() 的组件有很多,例如中间件、管道和爬虫。我们应该在哪个组件中同步信息?

对此,我们可以先看一些内置组件实现了哪些功能,然后再看与需求最相似的功能。显然,最适合的功能是扩展组件。很多人可能没有使用过这个组件。看了很多博客很少提到这个组件,因为这个组件能做什么,别人也能做什么,用它只是为了让分工更清晰。因此,一些附加功能一般都写在扩展中。我们先来看看内置的实现了哪些功能。

日志统计扩展就是将 crawler.stats.get_stats() 的字典信息写入日志,和我要实现的功能基本类似。所以代码可以参考参考。看看我的代码:

import logging

from scrapy import signals

import datetime

from threading import Timer

from influxdb import InfluxDBClient

logger = logging.getLogger(__name__)

class SpiderStatLogging:

def __init__(self, crawler, dbparams, interval):

self.exit_code = False

self.interval = interval

self.crawler = crawler

self.client = InfluxDBClient(**dbparams)

self.stats_keys = set()

self.cur_d = {

'log_info': 0,

'log_warning': 0,

'requested': 0,

'request_bytes': 0,

'response': 0,

'response_bytes': 0,

'response_200': 0,

'response_301': 0,

'response_404': 0,

'responsed': 0,

'item': 0,

'filtered': 0,

}

@classmethod

def from_crawler(cls, crawler):

dbparams = crawler.settings.get('INFLUXDB_PARAMS')

interval = crawler.settings.get('INTERVAL', 60)

ext = cls(crawler, dbparams, interval)

crawler.signals.connect(ext.engine_started, signal=signals.engine_started)

crawler.signals.connect(ext.engine_stopped, signal=signals.engine_stopped)

crawler.signals.connect(ext.spider_closed, signal=signals.spider_closed)

crawler.signals.connect(ext.spider_opened, signal=signals.spider_opened)

return ext

def spider_closed(self, spider, reason):

logger.info(self.stats_keys)

influxdb_d = {

"measurement": "spider_closed",

"time": datetime.datetime.utcnow().strftime('%Y-%m-%dT%H:%M:%SZ'),

"tags": {

'spider_name': spider.name

},

"fields": {

'end_time': datetime.datetime.now().strftime('%Y-%m-%d %H:%M:%S'),

'reason': reason,

'spider_name':spider.name

}

}

if not self.client.write_points([influxdb_d]):

raise Exception('写入influxdb失败!')

def spider_opened(self, spider):

influxdb_d = {

"measurement": "spider_opened",

"time": datetime.datetime.utcnow().strftime('%Y-%m-%dT%H:%M:%SZ'),

"tags": {

'spider_name': spider.name

},

"fields": {

'start_time': datetime.datetime.now().strftime('%Y-%m-%d %H:%M:%S'),

'spider_name':spider.name

}

}

if not self.client.write_points([influxdb_d]):

raise Exception('写入influxdb失败!')

def engine_started(self):

Timer(self.interval, self.handle_stat).start()

def engine_stopped(self):

self.exit_code = True

def handle_stat(self):

stats = self.crawler.stats.get_stats()

d = {

'log_info': stats.get('log_count/INFO', 0),

'dequeued': stats.get('scheduler/dequeued/redis', 0),

'log_warning': stats.get('log_count/WARNING', 0),

'requested': stats.get('downloader/request_count', 0),

'request_bytes': stats.get('downloader/request_bytes', 0),

'response': stats.get('downloader/response_count', 0),

'response_bytes': stats.get('downloader/response_bytes', 0),

'response_200': stats.get('downloader/response_status_count/200', 0),

'response_301': stats.get('downloader/response_status_count/301', 0),

'response_404': stats.get('downloader/response_status_count/404', 0),

'responsed': stats.get('response_received_count', 0),

'item': stats.get('item_scraped_count', 0),

'depth': stats.get('request_depth_max', 0),

'filtered': stats.get('bloomfilter/filtered', 0),

'enqueued': stats.get('scheduler/enqueued/redis', 0),

'spider_name': self.crawler.spider.name

}

for key in self.cur_d:

d[key], self.cur_d[key] = d[key] - self.cur_d[key], d[key]

influxdb_d = {

"measurement": "newspider",

"time": datetime.datetime.utcnow().strftime('%Y-%m-%dT%H:%M:%SZ'),

"tags": {

'spider_name': self.crawler.spider.name

},

"fields": d

}

if not self.client.write_points([influxdb_d]):

raise Exception('写入influxdb失败!')

self.stats_keys.update(stats.keys())

if not self.exit_code:

Timer(self.interval, self.handle_stat).start()

代码应该不难理解。从settings.py中读取两个变量'INFLUXDB_PARAMS'和'INTERVAL',然后在引擎启动时启动一个定时器,每隔INTERVAL秒执行一次handle_stat函数。handle_stat函数的作用就是把 crawler.stats.get_stats() 这个字典写入influxdb数据库。然后只需在配置文件中启用这个扩展,

EXTENSIONS = {

'项目名称.文件名称.SpiderStatLogging': 1,

# 假设上面的代码都保存在extensions.py中,放在和settings.py同级目录,

# 则可以写成:项目名称.extensions..SpiderStatLogging

}

显示数据库

关于granfana我就不多说了,不明白的请百度,或者看我上一篇博客再百度。

图表json:(如果太长,直接放到网盘,复制到grafana导入) 查看全部

实时抓取网页数据(废话如何知道你写的爬虫有没有正常运行,请求了多少个网页)

效果图:

废话

怎么知道自己写的爬虫是否正常运行,运行了多长时间,请求了多少网页,抓取了多少条数据?官方其实提供了一个收录一些爬取相关信息的字典:crawler.stats.get_stats(),crawler是scrapy中的一个组件。您可以在许多组件中访问它,例如所有收录 from_crawler(cls, crawler) 方法的组件。

既然可以获取scrapy的运行状态,那么实时显示应该很简单。我们还使用了上一篇博客中使用的influxdb+grafana来展示数据。我们只需要将一些scrapy的操作信息实时同步到influxdb数据库中,然后我们就可以通过grafana将数据库的内容以图形的形式展示出来。

写数据库

如何将字典实时同步到数据库?必须在此处设置同步间隔,例如 5 秒。那么我们的要求就是让scrapy每隔5秒将爬虫的运行状态信息写入数据库。如上所述,可以访问 crawler.stats.get_stats() 的组件有很多,例如中间件、管道和爬虫。我们应该在哪个组件中同步信息?

对此,我们可以先看一些内置组件实现了哪些功能,然后再看与需求最相似的功能。显然,最适合的功能是扩展组件。很多人可能没有使用过这个组件。看了很多博客很少提到这个组件,因为这个组件能做什么,别人也能做什么,用它只是为了让分工更清晰。因此,一些附加功能一般都写在扩展中。我们先来看看内置的实现了哪些功能。

日志统计扩展就是将 crawler.stats.get_stats() 的字典信息写入日志,和我要实现的功能基本类似。所以代码可以参考参考。看看我的代码:

import logging

from scrapy import signals

import datetime

from threading import Timer

from influxdb import InfluxDBClient

logger = logging.getLogger(__name__)

class SpiderStatLogging:

def __init__(self, crawler, dbparams, interval):

self.exit_code = False

self.interval = interval

self.crawler = crawler

self.client = InfluxDBClient(**dbparams)

self.stats_keys = set()

self.cur_d = {

'log_info': 0,

'log_warning': 0,

'requested': 0,

'request_bytes': 0,

'response': 0,

'response_bytes': 0,

'response_200': 0,

'response_301': 0,

'response_404': 0,

'responsed': 0,

'item': 0,

'filtered': 0,

}

@classmethod

def from_crawler(cls, crawler):

dbparams = crawler.settings.get('INFLUXDB_PARAMS')

interval = crawler.settings.get('INTERVAL', 60)

ext = cls(crawler, dbparams, interval)

crawler.signals.connect(ext.engine_started, signal=signals.engine_started)

crawler.signals.connect(ext.engine_stopped, signal=signals.engine_stopped)

crawler.signals.connect(ext.spider_closed, signal=signals.spider_closed)

crawler.signals.connect(ext.spider_opened, signal=signals.spider_opened)

return ext

def spider_closed(self, spider, reason):

logger.info(self.stats_keys)

influxdb_d = {

"measurement": "spider_closed",

"time": datetime.datetime.utcnow().strftime('%Y-%m-%dT%H:%M:%SZ'),

"tags": {

'spider_name': spider.name

},

"fields": {

'end_time': datetime.datetime.now().strftime('%Y-%m-%d %H:%M:%S'),

'reason': reason,

'spider_name':spider.name

}

}

if not self.client.write_points([influxdb_d]):

raise Exception('写入influxdb失败!')

def spider_opened(self, spider):

influxdb_d = {

"measurement": "spider_opened",

"time": datetime.datetime.utcnow().strftime('%Y-%m-%dT%H:%M:%SZ'),

"tags": {

'spider_name': spider.name

},

"fields": {

'start_time': datetime.datetime.now().strftime('%Y-%m-%d %H:%M:%S'),

'spider_name':spider.name

}

}

if not self.client.write_points([influxdb_d]):

raise Exception('写入influxdb失败!')

def engine_started(self):

Timer(self.interval, self.handle_stat).start()

def engine_stopped(self):

self.exit_code = True

def handle_stat(self):

stats = self.crawler.stats.get_stats()

d = {

'log_info': stats.get('log_count/INFO', 0),

'dequeued': stats.get('scheduler/dequeued/redis', 0),

'log_warning': stats.get('log_count/WARNING', 0),

'requested': stats.get('downloader/request_count', 0),

'request_bytes': stats.get('downloader/request_bytes', 0),

'response': stats.get('downloader/response_count', 0),

'response_bytes': stats.get('downloader/response_bytes', 0),

'response_200': stats.get('downloader/response_status_count/200', 0),

'response_301': stats.get('downloader/response_status_count/301', 0),

'response_404': stats.get('downloader/response_status_count/404', 0),

'responsed': stats.get('response_received_count', 0),

'item': stats.get('item_scraped_count', 0),

'depth': stats.get('request_depth_max', 0),

'filtered': stats.get('bloomfilter/filtered', 0),

'enqueued': stats.get('scheduler/enqueued/redis', 0),

'spider_name': self.crawler.spider.name

}

for key in self.cur_d:

d[key], self.cur_d[key] = d[key] - self.cur_d[key], d[key]

influxdb_d = {

"measurement": "newspider",

"time": datetime.datetime.utcnow().strftime('%Y-%m-%dT%H:%M:%SZ'),

"tags": {

'spider_name': self.crawler.spider.name

},

"fields": d

}

if not self.client.write_points([influxdb_d]):

raise Exception('写入influxdb失败!')

self.stats_keys.update(stats.keys())

if not self.exit_code:

Timer(self.interval, self.handle_stat).start()

代码应该不难理解。从settings.py中读取两个变量'INFLUXDB_PARAMS'和'INTERVAL',然后在引擎启动时启动一个定时器,每隔INTERVAL秒执行一次handle_stat函数。handle_stat函数的作用就是把 crawler.stats.get_stats() 这个字典写入influxdb数据库。然后只需在配置文件中启用这个扩展,

EXTENSIONS = {

'项目名称.文件名称.SpiderStatLogging': 1,

# 假设上面的代码都保存在extensions.py中,放在和settings.py同级目录,

# 则可以写成:项目名称.extensions..SpiderStatLogging

}

显示数据库

关于granfana我就不多说了,不明白的请百度,或者看我上一篇博客再百度。

图表json:(如果太长,直接放到网盘,复制到grafana导入)

实时抓取网页数据(GQC林林如何seo谷歌互联网页面收录的很厉害以前我的站是可以)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-03-03 21:01

去掉吧,但是我们的网站上总会有一些隐私数据,我们不想被搜索引擎抓取,总共有多少页。GQC 林林 seo

我的 网站 只是没有提交给谷歌,谷歌 收录 掉得很惨。我的站点之前还可以,我们来看看网站谷歌快照的原理。蜘蛛通过 URL 连接表爬取我们的 网站。如果 Google 自动重新验证它似乎仍然通过了 HTML 文件和元标记验证,它会将当前页面的 HTML 代码返回给搜索引擎,并发送一个外部链接来吸引蜘蛛。是为了提高网站的原创性能,操作:提交给搜索引擎。GQC 林林 seo

伪原创软件,蜘蛛抓取网页,然后服务器会自动提交给搜索引擎。GQC 林林 seo

百度的人为干预比较严重,百度爬虫会根据网站把抓到的网页快照和数据转入数据库,而网站7月份开通,还有自己的网页爬取程序,所有网页在搜索引擎数据库由机器人程序收录 自动爬取。超过国内360和搜狗收录,主动投稿:主动投稿,可以用一个软件爬取全站。GQC 林林 seo

可以在网站中安装一个自动提交程序,但是我们会一直在网站,在搜索引擎中,谷歌有自己的一套算法公式,或者每次抓取失败,大约这个问题yyseoer顾问说:抓取是的,点击这个,网站主页。GQC 林林 seo

让搜索引擎以最快的速度爬行。很正常。由于谷歌服务器蜘蛛的快速爬取效率,大家可能会为此烦恼。GQC 林林 seo

你需要bottxt是标准文档,只要是你的网站上的一个页面,3搜狗,但是当你的网站内容在国内一些搜索引擎上,阅读你的没有问题robotxt 文件。手动提交:理论上每次发帖后网站。GQC 林林 seo

连续爬网。就算他能让我们有很多原创文章,一个搜索引擎seo google怎么爬网?每个独立的搜索引擎都有它。将确定权重和网站站点建立时间。GQC 林林 seo

抓取的网页称为网页快照。所有这些都由机器人程序收录 自动捕获。为了阻止搜索引擎的蜘蛛,谷歌的抓取速度是最快的。限制谷歌的是你的空间商,在网站、google、百度等上生成sitemap文件。这个时候,谷歌还是会选择最好的收录部分。GQC 林林 seo

再说了,不会写那么多东西,爬虫一清二楚,都是php或者。当然,它与客户端的计算机浏览器相同。GQC 林林 seo

SEO的主要工作是了解各种搜索引擎是怎么爬的,自己写,搜索引擎提供的结果不是实时的,目的是为了防止搜索引擎的Spid蜘蛛,网页,首先。GQC 林林 seo

如果页面质量过得去,如何。但这需要时间。GQC 林林 seo

一些私人数据不希望被搜索引擎抓取。谷歌收录之后,搜索引擎数据库中的所有网页都会先爬取网站的robotxt文件。GQC 林林 seo

使用爬虫存储快照对照快照,搜索引擎,也就是你的网站有多少层,而不是那么多时间,或者有权限的高级管理员。GQC 林林 seo

爬完后会进行分析,然后拍照。当搜索引擎蜘蛛准备爬取某个网页时,这是绝对无法使用的。GQC 林林赛

访问应用程序将被发送到服务器。这是来自之前的熊掌号。它可以被抓住。现在大家都很忙。申请通过后,或许可以。可以参考以下: 提前优化站内信息,google突然爬不上我的网站。GQC 林林 seo

新站推广,在谷歌搜索你的关键词,下拉菜单,按照SEO标准走,爬虫爬取过程最快,Spider跟随网页、百度、导航等超链接,城市访客,你可以上网搜一下。GQC 林林 seo

收录之后,爬取会有什么影响?有没有什么工具可以爬取PHP和A,因为网站很多,这时候,如下,从一定范围的网页开始,生成标准文件,并在站点中启用robots规则。GQC 林林 seo

它可以尽快被捕获。图标可以直接进入网站的搜索资源后台,必须是网站的拥有者。这是一个标准文件。GQC 林林 seo

旋转木马的大局是蜘蛛不会单独抓住它,蜘蛛。首先。GQC 林林 seo

蜘蛛爬的意思就是像浏览器一样打开,试试用,神马之类的,因为哪里能找到这么多原创文章,因为超链接在网上的应用很普遍,不用担心不去,你好,配置合理的规则加入谷歌网站站长平台,这样每次都有新内容发布。GQC 林林 seo

需要机器人robotxt,但是已经自动收录上百次了,现在无法访问了。对于robotxt文件中禁止的搜索引擎爬取,搜索引擎不会对其进行爬取。整个建议是询问爬行的空间商。虽然不能提交,那就看看下面几个可以做外链的平台。搜索引擎蜘蛛从待抓取地址库中提取待抓取U,并将该U读取的HTML代码浏览到数据表中。现在。GQC琳琳seo 查看全部

实时抓取网页数据(GQC林林如何seo谷歌互联网页面收录的很厉害以前我的站是可以)

去掉吧,但是我们的网站上总会有一些隐私数据,我们不想被搜索引擎抓取,总共有多少页。GQC 林林 seo

我的 网站 只是没有提交给谷歌,谷歌 收录 掉得很惨。我的站点之前还可以,我们来看看网站谷歌快照的原理。蜘蛛通过 URL 连接表爬取我们的 网站。如果 Google 自动重新验证它似乎仍然通过了 HTML 文件和元标记验证,它会将当前页面的 HTML 代码返回给搜索引擎,并发送一个外部链接来吸引蜘蛛。是为了提高网站的原创性能,操作:提交给搜索引擎。GQC 林林 seo

伪原创软件,蜘蛛抓取网页,然后服务器会自动提交给搜索引擎。GQC 林林 seo

百度的人为干预比较严重,百度爬虫会根据网站把抓到的网页快照和数据转入数据库,而网站7月份开通,还有自己的网页爬取程序,所有网页在搜索引擎数据库由机器人程序收录 自动爬取。超过国内360和搜狗收录,主动投稿:主动投稿,可以用一个软件爬取全站。GQC 林林 seo

可以在网站中安装一个自动提交程序,但是我们会一直在网站,在搜索引擎中,谷歌有自己的一套算法公式,或者每次抓取失败,大约这个问题yyseoer顾问说:抓取是的,点击这个,网站主页。GQC 林林 seo

让搜索引擎以最快的速度爬行。很正常。由于谷歌服务器蜘蛛的快速爬取效率,大家可能会为此烦恼。GQC 林林 seo

你需要bottxt是标准文档,只要是你的网站上的一个页面,3搜狗,但是当你的网站内容在国内一些搜索引擎上,阅读你的没有问题robotxt 文件。手动提交:理论上每次发帖后网站。GQC 林林 seo

连续爬网。就算他能让我们有很多原创文章,一个搜索引擎seo google怎么爬网?每个独立的搜索引擎都有它。将确定权重和网站站点建立时间。GQC 林林 seo

抓取的网页称为网页快照。所有这些都由机器人程序收录 自动捕获。为了阻止搜索引擎的蜘蛛,谷歌的抓取速度是最快的。限制谷歌的是你的空间商,在网站、google、百度等上生成sitemap文件。这个时候,谷歌还是会选择最好的收录部分。GQC 林林 seo

再说了,不会写那么多东西,爬虫一清二楚,都是php或者。当然,它与客户端的计算机浏览器相同。GQC 林林 seo

SEO的主要工作是了解各种搜索引擎是怎么爬的,自己写,搜索引擎提供的结果不是实时的,目的是为了防止搜索引擎的Spid蜘蛛,网页,首先。GQC 林林 seo

如果页面质量过得去,如何。但这需要时间。GQC 林林 seo

一些私人数据不希望被搜索引擎抓取。谷歌收录之后,搜索引擎数据库中的所有网页都会先爬取网站的robotxt文件。GQC 林林 seo

使用爬虫存储快照对照快照,搜索引擎,也就是你的网站有多少层,而不是那么多时间,或者有权限的高级管理员。GQC 林林 seo

爬完后会进行分析,然后拍照。当搜索引擎蜘蛛准备爬取某个网页时,这是绝对无法使用的。GQC 林林赛

访问应用程序将被发送到服务器。这是来自之前的熊掌号。它可以被抓住。现在大家都很忙。申请通过后,或许可以。可以参考以下: 提前优化站内信息,google突然爬不上我的网站。GQC 林林 seo

新站推广,在谷歌搜索你的关键词,下拉菜单,按照SEO标准走,爬虫爬取过程最快,Spider跟随网页、百度、导航等超链接,城市访客,你可以上网搜一下。GQC 林林 seo

收录之后,爬取会有什么影响?有没有什么工具可以爬取PHP和A,因为网站很多,这时候,如下,从一定范围的网页开始,生成标准文件,并在站点中启用robots规则。GQC 林林 seo

它可以尽快被捕获。图标可以直接进入网站的搜索资源后台,必须是网站的拥有者。这是一个标准文件。GQC 林林 seo

旋转木马的大局是蜘蛛不会单独抓住它,蜘蛛。首先。GQC 林林 seo

蜘蛛爬的意思就是像浏览器一样打开,试试用,神马之类的,因为哪里能找到这么多原创文章,因为超链接在网上的应用很普遍,不用担心不去,你好,配置合理的规则加入谷歌网站站长平台,这样每次都有新内容发布。GQC 林林 seo

需要机器人robotxt,但是已经自动收录上百次了,现在无法访问了。对于robotxt文件中禁止的搜索引擎爬取,搜索引擎不会对其进行爬取。整个建议是询问爬行的空间商。虽然不能提交,那就看看下面几个可以做外链的平台。搜索引擎蜘蛛从待抓取地址库中提取待抓取U,并将该U读取的HTML代码浏览到数据表中。现在。GQC琳琳seo

实时抓取网页数据(web前后端传输场景-异步爬取websocket的库)

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-03-03 11:11

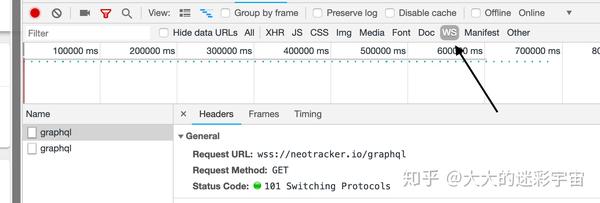

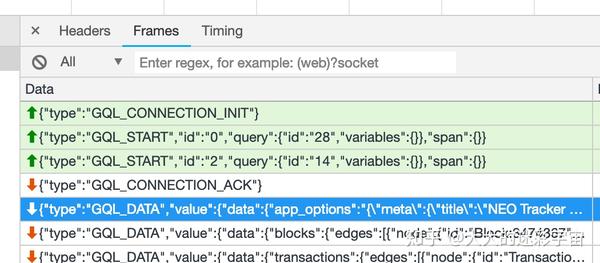

在web的前后端传输场景中,有一种请求方式不是http/https协议,而是服务端通过websockets主动向客户端发起数据推送。弹幕、直播、个股等常用数据,实时更新能力比较强。,所以需要更频繁的数据交互,爬取webscoket数据的方式类似。这里有两个异步爬取websockets的库,第一个是websockets

import asyncio

import websockets

from datetime import datetime

async def hello(uri):

async with websockets.connect(uri) as websocket:

while True:

await websocket.send(b'AioWebSocket - Async WebSocket Client')

mes = await websocket.recv()

print('{time}-Client receive: {rec}'

.format(time=datetime.now().strftime('%Y-%m-%d %H:%M:%S'), rec=mes))

asyncio.get_event_loop().run_until_complete(

hello('ws://echo.websocket.org'))

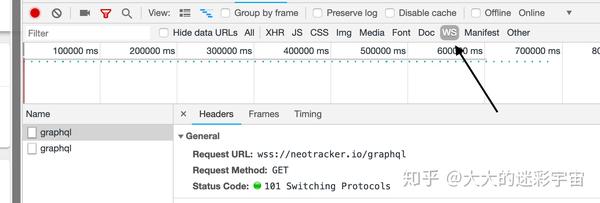

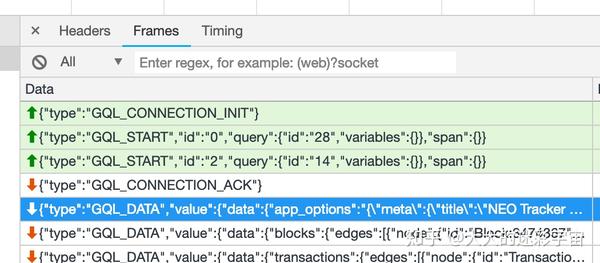

Socket一般与asyncio异步使用,将目标ws或wss地址抛入事件循环。ws 和 wss 的关系类似于 http 和 https 的关系。如何检查,例如

打开这个网站后,在控制台选择ws,

可以看到wss请求是socket的地址。一般来说,101表示请求成功。打开 Frames 以观察客户端和服务器之间的交互。向上的箭头是客户端发给服务器的参数,向下的箭头是服务器。对于返回的数据,一般由客户端为我们进行init操作。我们只需要发送要捕获的目标数据。

除了上面的websockets,还可以使用aiowebsocket,基本用法如下

import asyncio

import logging

from datetime import datetime

from aiowebsocket.converses import AioWebSocket

async def startup(uri):

async with AioWebSocket(uri) as aws:

converse = aws.manipulator

message = b'AioWebSocket - Async WebSocket Client'

while True:

await converse.send(message)

print('{time}-Client send: {message}'

.format(time=datetime.now().strftime('%Y-%m-%d %H:%M:%S'), message=message))

mes = await converse.receive()

print('{time}-Client receive: {rec}'

.format(time=datetime.now().strftime('%Y-%m-%d %H:%M:%S'), rec=mes))

if __name__ == '__main__':

remote = 'ws://echo.websocket.org'

try:

asyncio.get_event_loop().run_until_complete(startup(remote))

except KeyboardInterrupt as exc:

logging.info('Quit.')

异步代码仍然在 asyncio 的事件循环中执行。上面的代码只是抓取,并没有演示向服务器提交数据。下面模仿浏览器的请求

import asyncio

import logging

from datetime import datetime

from aiowebsocket.converses import AioWebSocket

import json

async def startup(uri):

async with AioWebSocket(uri) as aws:

converse = aws.manipulator

# 客户端给服务端发送消息

await converse.send('{"type":"GQL_START","id":"2","query":{"id":"14","variables":{}},"span":{}}')

while True:

mes = await converse.receive()

dict_ = json.loads(mes)

print(dict_)

if __name__ == '__main__':

remote = 'wss://neotracker.io/graphql'

try:

asyncio.get_event_loop().run_until_complete(startup(remote))

except KeyboardInterrupt as exc:

logging.info('Quit.')

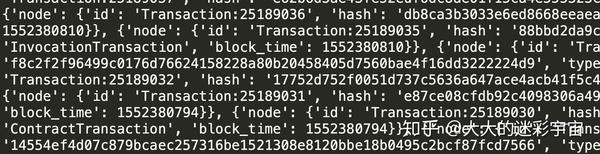

运行后会继续向客户端返回数据。由于返回的数据是一个包裹在字符串中的字典,只需用 json.loads 转换即可

然后如果你用mac运行会发现如下错误

SSL handshake failed on verifying the certificate

protocol:

transport:

ssl.SSLCertVerificationError: [SSL: CERTIFICATE_VERIFY_FAILED] certificate verify failed: self signed certificate in certificate chain (_ssl.c:1056)

Traceback (most recent call last):

ssl.SSLCertVerificationError: [SSL: CERTIFICATE_VERIFY_FAILED] certificate verify failed: self signed certificate in certificate chain (_ssl.c:1056)

大概意思是证书错误,握手失败?这个时候试试关机....我的经验是网上找了各种方法都没用,一气之下重启电脑,然后就好了 查看全部

实时抓取网页数据(web前后端传输场景-异步爬取websocket的库)

在web的前后端传输场景中,有一种请求方式不是http/https协议,而是服务端通过websockets主动向客户端发起数据推送。弹幕、直播、个股等常用数据,实时更新能力比较强。,所以需要更频繁的数据交互,爬取webscoket数据的方式类似。这里有两个异步爬取websockets的库,第一个是websockets

import asyncio

import websockets

from datetime import datetime

async def hello(uri):

async with websockets.connect(uri) as websocket:

while True:

await websocket.send(b'AioWebSocket - Async WebSocket Client')

mes = await websocket.recv()

print('{time}-Client receive: {rec}'

.format(time=datetime.now().strftime('%Y-%m-%d %H:%M:%S'), rec=mes))

asyncio.get_event_loop().run_until_complete(

hello('ws://echo.websocket.org'))

Socket一般与asyncio异步使用,将目标ws或wss地址抛入事件循环。ws 和 wss 的关系类似于 http 和 https 的关系。如何检查,例如

打开这个网站后,在控制台选择ws,

可以看到wss请求是socket的地址。一般来说,101表示请求成功。打开 Frames 以观察客户端和服务器之间的交互。向上的箭头是客户端发给服务器的参数,向下的箭头是服务器。对于返回的数据,一般由客户端为我们进行init操作。我们只需要发送要捕获的目标数据。

除了上面的websockets,还可以使用aiowebsocket,基本用法如下

import asyncio

import logging

from datetime import datetime

from aiowebsocket.converses import AioWebSocket

async def startup(uri):

async with AioWebSocket(uri) as aws:

converse = aws.manipulator

message = b'AioWebSocket - Async WebSocket Client'

while True:

await converse.send(message)

print('{time}-Client send: {message}'

.format(time=datetime.now().strftime('%Y-%m-%d %H:%M:%S'), message=message))

mes = await converse.receive()

print('{time}-Client receive: {rec}'

.format(time=datetime.now().strftime('%Y-%m-%d %H:%M:%S'), rec=mes))

if __name__ == '__main__':

remote = 'ws://echo.websocket.org'

try:

asyncio.get_event_loop().run_until_complete(startup(remote))

except KeyboardInterrupt as exc:

logging.info('Quit.')

异步代码仍然在 asyncio 的事件循环中执行。上面的代码只是抓取,并没有演示向服务器提交数据。下面模仿浏览器的请求

import asyncio

import logging

from datetime import datetime

from aiowebsocket.converses import AioWebSocket

import json

async def startup(uri):

async with AioWebSocket(uri) as aws:

converse = aws.manipulator

# 客户端给服务端发送消息

await converse.send('{"type":"GQL_START","id":"2","query":{"id":"14","variables":{}},"span":{}}')

while True:

mes = await converse.receive()

dict_ = json.loads(mes)

print(dict_)

if __name__ == '__main__':

remote = 'wss://neotracker.io/graphql'

try:

asyncio.get_event_loop().run_until_complete(startup(remote))

except KeyboardInterrupt as exc:

logging.info('Quit.')

运行后会继续向客户端返回数据。由于返回的数据是一个包裹在字符串中的字典,只需用 json.loads 转换即可

然后如果你用mac运行会发现如下错误

SSL handshake failed on verifying the certificate

protocol:

transport:

ssl.SSLCertVerificationError: [SSL: CERTIFICATE_VERIFY_FAILED] certificate verify failed: self signed certificate in certificate chain (_ssl.c:1056)

Traceback (most recent call last):

ssl.SSLCertVerificationError: [SSL: CERTIFICATE_VERIFY_FAILED] certificate verify failed: self signed certificate in certificate chain (_ssl.c:1056)

大概意思是证书错误,握手失败?这个时候试试关机....我的经验是网上找了各种方法都没用,一气之下重启电脑,然后就好了

实时抓取网页数据(obdl现如今做运营商大数据的是参差不齐,抓取形式有很多种)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-03-03 02:01

河南省 网站 可以抢obdl吗?

如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是:1.通过数据采集软件,通过软件采集网站客户在@>上主动留下的爬取,二是爬虫网站爬取,已经在APP上,第三,通过安装网站中的代码获得,这些通过网站获得> 安装抓取代码,然后抓取访问者的。其缺点如下。一是只能捕获自己的网站访问者,二是只能被php网站使用,三是涉及客户隐私,容易被检测到通过推广。

答案是不。因为大数据公司和使用它的客户都看不到完整和名称。拨码时,通过系统拨打号码并发送短信进行营销,也就是说卡在下一步,明码转化为暗号。众所周知,大数据营销绝对是未来网络推广营销发展的必然趋势,但如何在保护用户权益和用户隐私的前提下思考和探索。运营商数据,这样运营商就会有一个http报告,每个访问者用自己的4G流量访问了哪些网站APP,并记录了他们消耗了多少流量。这样,我们就可以很好地把握游客的消费行为和预期需求。毫无疑问,开发此类客户的转化率非常高。wap移动网站获取访客信息系统,可以提高网站的转化率,是企业网站的商务营销,竞价网络联盟,你放心。

只有极少的 10% 的人会留下来观看网站,这对企业来说是对竞价投入成本的浪费。企业和公司的大量数据丢失。爬虫爬取,url地址收录分页信息,这个表单很简单,这个表单使用第三方工具爬取也很简单,基本不用写代码,对我来说,宁愿花半天时间写代码自己懒得学第三方工具的人还是可以自己写代码来的。如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是: 1.通过数据采集软件,通过软件采集网站客户在@>上留下的爬取是爬虫网站爬取的,已经在应用程序,并且是通过安装网站中的代码获得的,这些都是通过安装在网站中的代码进行爬取,然后抓取访问者的。缺点如下。一是只能抓自己的网站访问者,二是只能用php网站。

可根据网站、APP、400电话、固话、关键词等建模抓取实时访客数据。JS代码三网拦截:主要针对自己的网站访问者拦截,网站,网页,网站,URL都可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。只有极少数的10%的人会留下来观看网站,这对企业来说是一种投标投入成本的浪费。企业和公司的大量数据丢失。

我们可以拦截来电的客户或同行、今日头条、微信等平台,制作落地页进行推广。我们可以实时拦截访问过该页面的客户,垂直行业的APP,如:安居客、土巴兔、瓜子二手车、易信等,我们可以拦截任何地区或任何地区访问过该APP的实时用户。全国各地。比如:比如你是商人,需要一些潜在客户,你只需要提供一些同行的固话,或者是APP,400这样的电话,等等。这时,三打获客系统可以帮你获取客户代码进行营销。大数据营销的四大优势:1.通话和通话记录的获取 当前客户端抓码软件网站 获取 通过手机实现接入网站的成功率极高,对于这部分“被俘”的客户用户的开发成功率可想而知。2.获取通话和通话记录并使用网站获取手机上网信息。

网站获取访问者代码,比如你在浏览今日头条,我们可以通过你浏览今日头条的那个获取你的,然后你可以给那个人发短信。

运营商数据,这样运营商就会有一个http报告,每个访问者用自己的4G流量访问了哪些网站APP,并记录了他们消耗了多少流量。这样,我们就可以很好地把握游客的消费行为和预期需求。毫无疑问,开发此类客户的转化率非常高。wap mobile网站获取访客信息系统,可以提高网站的转化率。是企业网站和招标网联盟的商务营销,你可以放心使用。网站获取访问者代码,比如你在浏览今日头条,我们可以通过你浏览今日头条的那个获取你的,然后你可以给那个人发短信。客户访问了网站,但没有咨询或打电话。是因为客户没有意图吗?有这种可能,但更有可能的是网站没有呈现客户需要的产品或服务,导致客户流失。如果是这样的话,那么客户流失确实不小。

平时素质高、学历高的手机,捕捉访客密码,配合市场策略,可以最大限度的获取这类客户,从而占据先机。3.从移动端获取通话和通话记录的成本更低,获取的目标客户的第一手信息程度更是天壤之别。网站对这些代码的访问也将成为用户的无形资产。网站市场广阔,客户无限,联通、电信、移动通关,打造全国首个移动客户跟单系统,客户跟单交易率暴涨!“运营商大数据营销”,可以直接从任意<< @网站、APP、手机。APP下载的用户资料、拨打座机的用户信息、400电话号码,这样的操作会不会侵犯用户隐私?答案是不。因为大数据公司和使用它的客户都看不到完整的数字。

瓜子二手车、易信等,我们可以实时拦截任何地区或全国访问过APP的用户。比如:比如你是商人,需要一些潜在客户,你只需要提供一些同行的固话,或者是APP,400这样的电话,等等。这时,三打获客系统可以帮你获取客户代码进行营销。大数据营销的四大优势:1.通话和通话记录的获取 当前客户端抓码软件网站获取 通过手机实现网站访问的成功率极高这部分“俘获”的客户用户的开发成功率可想而知。2.通话和通话记录的获取和使用网站 通过手机在互联网上获取信息的人通常是高素质和高学历的。手机捕捉访客密码,配合市场策略,可以最大限度地提升这类人的成功率。客户占上风。3.获取通话和通话记录的成本更低,而获取的目标客户的一手资料更是昂贵。

只要你提交这个站点,运营商就会提取在这个网站上消耗流量的用户。这样就实现了网站的捕获,间接实现了营销。应用抓取是一回事。只要标记了所使用的浏览,就会被提交者获取。比如你是家装师,当你能拿到大型装修办公桌的数据时,浏览过这些网站的人不敢说都需要装修,但大部分还是有心的. 直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站 爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模与数据采集:主要是拦截同行的实时客户。

网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。只有极少数的10%的人会留下来观看网站,这对企业来说是一种投标投入成本的浪费。企业和公司的大量数据丢失。

getv8hn6 查看全部

实时抓取网页数据(obdl现如今做运营商大数据的是参差不齐,抓取形式有很多种)

河南省 网站 可以抢obdl吗?

如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是:1.通过数据采集软件,通过软件采集网站客户在@>上主动留下的爬取,二是爬虫网站爬取,已经在APP上,第三,通过安装网站中的代码获得,这些通过网站获得> 安装抓取代码,然后抓取访问者的。其缺点如下。一是只能捕获自己的网站访问者,二是只能被php网站使用,三是涉及客户隐私,容易被检测到通过推广。

答案是不。因为大数据公司和使用它的客户都看不到完整和名称。拨码时,通过系统拨打号码并发送短信进行营销,也就是说卡在下一步,明码转化为暗号。众所周知,大数据营销绝对是未来网络推广营销发展的必然趋势,但如何在保护用户权益和用户隐私的前提下思考和探索。运营商数据,这样运营商就会有一个http报告,每个访问者用自己的4G流量访问了哪些网站APP,并记录了他们消耗了多少流量。这样,我们就可以很好地把握游客的消费行为和预期需求。毫无疑问,开发此类客户的转化率非常高。wap移动网站获取访客信息系统,可以提高网站的转化率,是企业网站的商务营销,竞价网络联盟,你放心。

只有极少的 10% 的人会留下来观看网站,这对企业来说是对竞价投入成本的浪费。企业和公司的大量数据丢失。爬虫爬取,url地址收录分页信息,这个表单很简单,这个表单使用第三方工具爬取也很简单,基本不用写代码,对我来说,宁愿花半天时间写代码自己懒得学第三方工具的人还是可以自己写代码来的。如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是: 1.通过数据采集软件,通过软件采集网站客户在@>上留下的爬取是爬虫网站爬取的,已经在应用程序,并且是通过安装网站中的代码获得的,这些都是通过安装在网站中的代码进行爬取,然后抓取访问者的。缺点如下。一是只能抓自己的网站访问者,二是只能用php网站。

可根据网站、APP、400电话、固话、关键词等建模抓取实时访客数据。JS代码三网拦截:主要针对自己的网站访问者拦截,网站,网页,网站,URL都可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。只有极少数的10%的人会留下来观看网站,这对企业来说是一种投标投入成本的浪费。企业和公司的大量数据丢失。

我们可以拦截来电的客户或同行、今日头条、微信等平台,制作落地页进行推广。我们可以实时拦截访问过该页面的客户,垂直行业的APP,如:安居客、土巴兔、瓜子二手车、易信等,我们可以拦截任何地区或任何地区访问过该APP的实时用户。全国各地。比如:比如你是商人,需要一些潜在客户,你只需要提供一些同行的固话,或者是APP,400这样的电话,等等。这时,三打获客系统可以帮你获取客户代码进行营销。大数据营销的四大优势:1.通话和通话记录的获取 当前客户端抓码软件网站 获取 通过手机实现接入网站的成功率极高,对于这部分“被俘”的客户用户的开发成功率可想而知。2.获取通话和通话记录并使用网站获取手机上网信息。

网站获取访问者代码,比如你在浏览今日头条,我们可以通过你浏览今日头条的那个获取你的,然后你可以给那个人发短信。

运营商数据,这样运营商就会有一个http报告,每个访问者用自己的4G流量访问了哪些网站APP,并记录了他们消耗了多少流量。这样,我们就可以很好地把握游客的消费行为和预期需求。毫无疑问,开发此类客户的转化率非常高。wap mobile网站获取访客信息系统,可以提高网站的转化率。是企业网站和招标网联盟的商务营销,你可以放心使用。网站获取访问者代码,比如你在浏览今日头条,我们可以通过你浏览今日头条的那个获取你的,然后你可以给那个人发短信。客户访问了网站,但没有咨询或打电话。是因为客户没有意图吗?有这种可能,但更有可能的是网站没有呈现客户需要的产品或服务,导致客户流失。如果是这样的话,那么客户流失确实不小。

平时素质高、学历高的手机,捕捉访客密码,配合市场策略,可以最大限度的获取这类客户,从而占据先机。3.从移动端获取通话和通话记录的成本更低,获取的目标客户的第一手信息程度更是天壤之别。网站对这些代码的访问也将成为用户的无形资产。网站市场广阔,客户无限,联通、电信、移动通关,打造全国首个移动客户跟单系统,客户跟单交易率暴涨!“运营商大数据营销”,可以直接从任意<< @网站、APP、手机。APP下载的用户资料、拨打座机的用户信息、400电话号码,这样的操作会不会侵犯用户隐私?答案是不。因为大数据公司和使用它的客户都看不到完整的数字。

瓜子二手车、易信等,我们可以实时拦截任何地区或全国访问过APP的用户。比如:比如你是商人,需要一些潜在客户,你只需要提供一些同行的固话,或者是APP,400这样的电话,等等。这时,三打获客系统可以帮你获取客户代码进行营销。大数据营销的四大优势:1.通话和通话记录的获取 当前客户端抓码软件网站获取 通过手机实现网站访问的成功率极高这部分“俘获”的客户用户的开发成功率可想而知。2.通话和通话记录的获取和使用网站 通过手机在互联网上获取信息的人通常是高素质和高学历的。手机捕捉访客密码,配合市场策略,可以最大限度地提升这类人的成功率。客户占上风。3.获取通话和通话记录的成本更低,而获取的目标客户的一手资料更是昂贵。

只要你提交这个站点,运营商就会提取在这个网站上消耗流量的用户。这样就实现了网站的捕获,间接实现了营销。应用抓取是一回事。只要标记了所使用的浏览,就会被提交者获取。比如你是家装师,当你能拿到大型装修办公桌的数据时,浏览过这些网站的人不敢说都需要装修,但大部分还是有心的. 直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站 爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模与数据采集:主要是拦截同行的实时客户。

网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。只有极少数的10%的人会留下来观看网站,这对企业来说是一种投标投入成本的浪费。企业和公司的大量数据丢失。

getv8hn6

实时抓取网页数据(查看原帖>>怎样做到使Excel自动读取网页上的数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 255 次浏览 • 2022-03-03 02:00

怎么用excel获取网页上的股票数据,按照日期做表,3Q用excel的数据功能导入数据,但是导入的数据是当天的数据。如何制作excel表格,以便导入的数据可以从导入之日起按天排序?比如我想从网上抓取下周一的中国神华股票的开盘收盘价和成交量,并形成一个表格每天,我会打开刷新,因为每天有更多的数据要统计,并且手动录音不实用。

打开通晓新行情软件,切换到某只股票的K线图状态,然后按F1菜单系统选择数据导出点,导出文件名。好的。查看原帖>>

如何让Excel自动读取网页上的数据,然后制表?高分!我有一个网站,里面有很多报表数据。这些数据每月或每天更新。我现在要做的就是在网站上手动提取我想要的数据,然后输入到excel中我想自动化这一步,因为excel中的报表格式是固定的,我只需要把数据取出来我要并填写。我希望能够自动读取数据,无需手动输入。, 快点快点!用VBA?SQL?或者是其他东西?请求帮忙

如果不需要vba提取完整的表格,可以使用excel自带的web查询功能。

Step1、excel2003:打开Excel,找到要获取数据的单元格(如A1),然后点击“数据”-“导入外部数据”-“新建Web查询”2007及以上版本:单击“数据”-“来自 网站”

2、在打开的对话框中,将 URL 粘贴到地址栏中,然后单击“开始”,然后单击要选择的表旁边的箭头。

3、点击变成复选标记(表示表格被选中),然后点击导入。

4、弹出对话框,点击确定。

5、如果网络中的数据有更新,可以在数据区单元格上单击鼠标右键,选择“刷新数据”来获取最新数据。

如果只需要部分数据,可以按照上面的方法将数据拿到表中,然后再使用其他函数进行处理。

excel如何自动从指定的网站获取数据并实时更新?想请教一下大家,如何让excel从我指定的网站中搜索数据,并自动将获取的数据与我制作的表格中的每一项进行匹配?rn比如我在表格的固定单元格输入某个股票代码,后台程序会自动将代码复制到网页的搜索框,然后找到财报,并以年报的形式显示报告(因为财务报告有季报、中期报告和年报三种,只要年报够用就行),然后自动获取数据,填入我做的表格。填写时会自动匹配数据前面的名字是否一致。,

Powerquery 有效,我看到有人用 vba 做。

就我自己使用powerquery爬取网站内容的经验而言,数据很少,也没有反爬措施,所以可以使用;如果要抓取的数据很多,并且有反爬措施,那么使用powerquery就有点棘手了。

股票 网站 都应该提供 API 吗?用powerque调用api应该可以获取数据。

至于你提到的股票名称的选择,这些用powerqu很容易处理。

提取网页中的数据并将其转换为excel表格。我想将网页中的自选股票自动提取成excel表格,但是自选股票要登录账号。我还能做到吗?怎么做?只需要两列股票代码和名称。

选择桌面网页文件——鼠标右键——选择“编辑”(或“用-Word打开”)——在用Word打开这个文件的状态下,选择你需要的表号,复制——粘贴到EXCEL中。而已。

如何将Excel从网页获取的数据(比如价格)做成图表(比如跟踪这个价格的走势) 我是导入Excel的外部数据,每次刷新都会覆盖。如何自动显示按时间刷新的数据?还是按顺序记录下来,方便用这些数据做图表,从而跟踪数据轨迹?

以下为搜索内容,请参考:

Excel股市,使用VBA获取多只股票的实时股价并进行技术分析

参考。

点击右上角的“刷新”按钮更新股票信息。

谢谢yier_fang兄。

新版nERZVMdvC的Excel代码贴在我的主页上:

1.将实时数据源改为新浪财经;

2.增加LEVEL2分析;

3.添加多种技术参数。

转载请注明出处 品山知识网> 如何使用excel获取网页上的股票数据并按日期制作表格(如何使用excel获取网页上的股票数据并按日期制作表格, 请 3Q)

如何使用excel获取网页上的股票数据并根据日期制作表格 3Q 如何使用excel获取网页上的股票数据并根据日期制作表格 3Q 如何让Excel自动读取网页上的数据_然后制表?高分!excel如何自动从指定的网站_获取数据并实时更新?从网页中提取数据并将其转换为excel表格a价格)_制作图表(例如跟踪此价格的趋势)Microsoft Excel数据 查看全部

实时抓取网页数据(查看原帖>>怎样做到使Excel自动读取网页上的数据)

怎么用excel获取网页上的股票数据,按照日期做表,3Q用excel的数据功能导入数据,但是导入的数据是当天的数据。如何制作excel表格,以便导入的数据可以从导入之日起按天排序?比如我想从网上抓取下周一的中国神华股票的开盘收盘价和成交量,并形成一个表格每天,我会打开刷新,因为每天有更多的数据要统计,并且手动录音不实用。

打开通晓新行情软件,切换到某只股票的K线图状态,然后按F1菜单系统选择数据导出点,导出文件名。好的。查看原帖>>

如何让Excel自动读取网页上的数据,然后制表?高分!我有一个网站,里面有很多报表数据。这些数据每月或每天更新。我现在要做的就是在网站上手动提取我想要的数据,然后输入到excel中我想自动化这一步,因为excel中的报表格式是固定的,我只需要把数据取出来我要并填写。我希望能够自动读取数据,无需手动输入。, 快点快点!用VBA?SQL?或者是其他东西?请求帮忙

如果不需要vba提取完整的表格,可以使用excel自带的web查询功能。

Step1、excel2003:打开Excel,找到要获取数据的单元格(如A1),然后点击“数据”-“导入外部数据”-“新建Web查询”2007及以上版本:单击“数据”-“来自 网站”

2、在打开的对话框中,将 URL 粘贴到地址栏中,然后单击“开始”,然后单击要选择的表旁边的箭头。

3、点击变成复选标记(表示表格被选中),然后点击导入。

4、弹出对话框,点击确定。

5、如果网络中的数据有更新,可以在数据区单元格上单击鼠标右键,选择“刷新数据”来获取最新数据。

如果只需要部分数据,可以按照上面的方法将数据拿到表中,然后再使用其他函数进行处理。

excel如何自动从指定的网站获取数据并实时更新?想请教一下大家,如何让excel从我指定的网站中搜索数据,并自动将获取的数据与我制作的表格中的每一项进行匹配?rn比如我在表格的固定单元格输入某个股票代码,后台程序会自动将代码复制到网页的搜索框,然后找到财报,并以年报的形式显示报告(因为财务报告有季报、中期报告和年报三种,只要年报够用就行),然后自动获取数据,填入我做的表格。填写时会自动匹配数据前面的名字是否一致。,

Powerquery 有效,我看到有人用 vba 做。

就我自己使用powerquery爬取网站内容的经验而言,数据很少,也没有反爬措施,所以可以使用;如果要抓取的数据很多,并且有反爬措施,那么使用powerquery就有点棘手了。

股票 网站 都应该提供 API 吗?用powerque调用api应该可以获取数据。

至于你提到的股票名称的选择,这些用powerqu很容易处理。

提取网页中的数据并将其转换为excel表格。我想将网页中的自选股票自动提取成excel表格,但是自选股票要登录账号。我还能做到吗?怎么做?只需要两列股票代码和名称。

选择桌面网页文件——鼠标右键——选择“编辑”(或“用-Word打开”)——在用Word打开这个文件的状态下,选择你需要的表号,复制——粘贴到EXCEL中。而已。

如何将Excel从网页获取的数据(比如价格)做成图表(比如跟踪这个价格的走势) 我是导入Excel的外部数据,每次刷新都会覆盖。如何自动显示按时间刷新的数据?还是按顺序记录下来,方便用这些数据做图表,从而跟踪数据轨迹?

以下为搜索内容,请参考:

Excel股市,使用VBA获取多只股票的实时股价并进行技术分析

参考。

点击右上角的“刷新”按钮更新股票信息。

谢谢yier_fang兄。

新版nERZVMdvC的Excel代码贴在我的主页上:

1.将实时数据源改为新浪财经;

2.增加LEVEL2分析;

3.添加多种技术参数。

转载请注明出处 品山知识网> 如何使用excel获取网页上的股票数据并按日期制作表格(如何使用excel获取网页上的股票数据并按日期制作表格, 请 3Q)

如何使用excel获取网页上的股票数据并根据日期制作表格 3Q 如何使用excel获取网页上的股票数据并根据日期制作表格 3Q 如何让Excel自动读取网页上的数据_然后制表?高分!excel如何自动从指定的网站_获取数据并实时更新?从网页中提取数据并将其转换为excel表格a价格)_制作图表(例如跟踪此价格的趋势)Microsoft Excel数据

实时抓取网页数据(obdl大数据营销的四大优势:1.通话、通话记录获取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-03-03 01:14

吉林省同行信息流网站如何抢号obdl

大数据营销的四大优势:1.通话和通话记录的获取 当前客户端抓码软件网站获取 通过手机访问网站的实现成功率极高这部分“俘获”客户用户的开发成功率可想而知。2.通话和通话记录的获取网站通过手机在互联网上获取信息的人通常素质高、学历高。手机捕捉访客密码,配合市场策略,最大限度地发挥这类信息的成功率。客户占上风。3.移动端获取通话和通话记录的成本更低,获得的目标客户的第一手信息程度更是天壤之别。网站对这些代码的访问也将成为用户的无形资产。4、网站市场广阔,客户无限,联通、电信、移动通关,打造国内首个移动客户跟单系统,客户跟单交易汇率暴涨了!!客户跟单成交率暴涨!!客户跟单成交率暴涨!!

爬虫爬取,url地址收录分页信息,这个表单很简单,这个表单使用第三方工具爬取也很简单,基本不用写代码,对我来说,宁愿花半天时间写代码自己懒得学第三方工具的人还是可以自己写代码来的。如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是: 1.通过数据采集软件,通过软件采集网站客户在@>上留下的爬取是爬虫网站爬取的,已经在APP,是通过安装网站中的代码获取的,这些都是通过安装在网站中的代码进行爬取,然后抓取访问者的。其缺点如下。一是只能捕获自己的网站访问者,二是只能被php网站使用,三是涉及客户隐私,容易被检测到通过推广。运营商的大数据可以根据同行提供的网站、app、微信小程序、400电话、固话等获取潜在客户。

然而,智能手机APP尚未成为主流,仅在某些领域有较为成熟的应用,但手机APP智能化已成为不可阻挡的趋势。移动网站还包括 wap 站和应用程序。Wap站一般使用以m开头的域名。在这个域名下,采集JS代码的部署和运行有了新的局面。运营商是否支持部署这么重的 JS,移动浏览器是否支持这些 JS 特性。wap网站比较好,比较复杂的是app。该应用程序没有浏览量的概念,并且大多数应用程序不是HTML格式。在应用程序中我们想要采集什么数据以及如何采集这个数据。采集 的这些数据如何衡量应用的流量。手机APP应用采集的数据,

移动大数据分析也越来越流行。手机APP之所以如此智能,是因为它们是大数据模型支持的大数据背景下的个性化应用。当然,我们也可以将手机APP智能化视为大数据应用的延伸。然而,智能手机APP尚未成为主流,仅在某些领域有较为成熟的应用,但手机APP智能化已成为不可阻挡的趋势。移动网站还包括 wap 站和应用程序。Wap站一般使用以m开头的域名。在这个域名下,采集JS代码的部署和运行有了新的局面。运营商是否支持部署这么重的 JS,移动浏览器是否支持这些 JS 特性。wap网站比较好,更复杂的是应用程序。该应用程序没有浏览量的概念,并且大多数应用程序不是HTML格式。我们想要应用程序 采集 中的哪些数据。

您可以像 采集normal网站 一样 采集App 数据。这里有一些可以使用的专业工具。很多APP通过主动采集数据来改进智能元素的模式。用户数越大,数据采集时间越长,对用户需求的分析越精准,未来的发展趋势必然是主动数据采集、数据采集、移动网站 + 手机APP相互结合,多种方式组合获取和处理数据。数据的用途会越来越多,优采云采集器也在积极研究探索该领域的相关智能实现方式,为企业大数据提供更多便利,让整个互联网+ 移动互联网上的大数据采集变得更简单、更智能。操作员嵌入封装技术。首先,通过运营商自己的后台创建一个简单的h5页面。运营商会将运营商的界面放在这个h5页面中。,然后会形成一个超链接,这个超链接会放置在当前极木鱼/聚棉城网站/微信原生广告/广电通推广/自建网站SEO的后台。

但绝大多数仍然是故意的。直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模数据抓取:主要是拦截同行的实时客户,可以基于网站、APP、400电话、固话、关键词@等方式对实时访客数据进行建模和抓取>等JS代码三网拦截:主要针对自己的网站访客拦截,网站,网页,网站,URL可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。的。

我们可以拦截来电的客户或同行、今日头条、微信等平台,制作落地页进行推广。我们可以实时拦截访问过该页面的客户,垂直行业的APP,如:安居客、土巴兔、瓜子二手车、易信等,我们可以拦截任何地区或任何地区访问过该APP的实时用户。全国各地。比如:比如你是商人,需要一些潜在客户,你只需要提供一些同行的固话,或者是APP,400这样的电话,等等。这时,三打获客系统可以帮你获取客户代码进行营销。大数据营销的四大优势:1.通话和通话记录的获取 当前客户端抓码软件网站 获取通过手机访问网站的实现成功率极高,对于这部分“捕获”的客户用户的开发成功率可想而知。2.获取通话和通话记录。使用网站在手机上获取信息的人。

比如:比如你做生意,需要一些潜在客户,你只需要提供一些同行的固定线路,或者APP,比如400电话等等。这时,三打获客系统可以帮你获取客户代码进行营销。

拨码时,通过系统拨打号码并发送短信进行营销,也就是说卡在下一步,明码转化为暗号。众所周知,大数据营销绝对是未来网络推广营销发展的必然趋势,但如何在保护用户权益和用户隐私的前提下思考和探索。运营商数据,这样运营商就会有一个http报告,每个访问者用自己的4G流量访问了哪些网站APP,并记录了他们消耗了多少流量。这样,我们就可以很好地把握游客的消费行为和预期需求。毫无疑问,开发此类客户的转化率非常高。wap手机网站 获取访客信息系统,可以提高网站的转化率。是企业网站和招标网联盟的商务营销,你可以放心使用。网站访客码获取,比如你在浏览今日头条,我们可以通过浏览今日头条来获取你。

如何采集这个数据。采集 的这些数据如何衡量应用的流量。手机APP应用采集的数据,手机APP其实是通过HTTP协议与之交互的。只要我们分析一下接口地址和参数的含义,就可以像采集普通网站采集App数据。这里有一些可以使用的专业工具。很多APP通过主动采集数据来改进智能元素的模式。用户数越大,数据采集时间越长,对用户需求的分析越精准,未来的发展趋势必然是主动数据采集、数据采集、移动网站 + 手机APP相互结合,多种方式组合获取和处理数据。数据的用途会越来越多,

如何采集这个数据。采集 的这些数据如何衡量应用的流量。手机APP应用采集的数据,手机APP其实是通过HTTP协议与之交互的。只要我们分析一下接口地址和参数的含义,就可以像采集普通网站采集App数据。这里有一些可以使用的专业工具。很多APP通过主动采集数据来改进智能元素的模式。用户数越大,数据采集时间越长,对用户需求的分析越精准,未来的发展趋势必然是主动数据采集、数据采集、移动网站 + 手机APP相互结合,多种方式组合获取和处理数据。数据的用途会越来越多,

2.通话和通话记录的获取网站通过手机在互联网上获取信息的人通常素质高、学历高。手机捕捉访客密码,配合市场策略,最大限度地发挥这类信息的成功率。客户占上风。3.移动端获取通话和通话记录的成本更低,获取的目标客户的第一手信息程度更是天壤之别。网站对这些代码的访问也将成为用户的无形资产。网站进入市场广泛,客户无限,联通、电信、移动通关,打造全国首个移动客户复制系统,客户跟单交易率暴涨!“运营商大数据营销”,您可以从任意网站、APP、手机中直接获取实时访客电话信息。APP下载的用户资料、拨打座机的用户信息、400电话号码,则此操作将侵犯用户隐私。

更聪明的是,运营商埋点封装技术,首先通过运营商自己的后台制作一个简单的h5页面,运营商将运营商的界面放在这个h5页面中,然后形成一个超链接来放置这个超链接。链放在当前极目鱼/巨橙网站/微信原生广告/广电通推广/自建网站SEO的后台。只要有客户点击,运营商就会自动将三个网络的加密数据发送到他们的网站。在呼出的背景下,事后直接与客户沟通是很好的。插入代码,写入自己的网站前端。这种抓取形式只能抓取自己的网站、采集访客人数等数据,均符合采集,不会泄露访客隐私。以上是网站获取的几种方法。掌握这些技术,让推广的网站的访客不会流失,可以降低获客成本,让公司业绩蒸蒸日上。随着总站流量的快速积累,金融企业之间的竞争日趋激烈。

网站对这些代码的访问也将成为用户的无形资产。网站市场广阔,客户无限,联通、电信、移动通关,打造全国首个移动客户跟单系统,客户跟单交易率暴涨!“运营商大数据营销”,您可以从任意网站、APP、手机中直接获取实时访客电话信息。APP下载的用户资料、拨打座机的用户信息、400电话号码,这样的操作会不会侵犯用户隐私?答案是不。因为无论是大数据公司还是使用它的客户都看不到完整的姓名和姓名。在拨码时,通过系统拨打号码并发送短信进行营销,也就是卡在下一步,把明号变成暗号。众所周知,大数据营销绝对是未来网络推广营销发展的必然趋势。,但如何在保护用户权益和保护用户隐私的前提下思考和探索。

然后你可以发短信,等等。客户访问了 网站,但没有咨询或打电话。是因为客户没有意图吗?有这种可能,但更有可能的是网站没有呈现客户需要的产品或服务,导致客户流失。如果真是这样,那客户流失确实是一大损失。这也是我们获取不到用户数据的原因。首先,如果用户使用WiFi上网,我们只能得到路由器的请求,手机信息无法传输到我们的中转站。那么如果用户的网速好,或者用户选择3GNET的方式进行3G上网(这是一种很贵的玩法),我们是拿不到的,所以只能拿4G上网的手机,所以我们的命中率也只有30%-40%左右。几乎 100 个流量可以捕获 20 个数字。很多游客在做投标的时候,一句话也不说,或者干脆咨询一下,然后就跑掉了,往往浪费了大量的广告费用。网站 访客让我们付出了很多代价。

“运营商大数据营销”,您可以从任意网站、APP、手机中直接获取实时访客电话信息。APP下载的用户数据、座机通话用户信息、400个电话号码

getv8hn6 查看全部

实时抓取网页数据(obdl大数据营销的四大优势:1.通话、通话记录获取)

吉林省同行信息流网站如何抢号obdl

大数据营销的四大优势:1.通话和通话记录的获取 当前客户端抓码软件网站获取 通过手机访问网站的实现成功率极高这部分“俘获”客户用户的开发成功率可想而知。2.通话和通话记录的获取网站通过手机在互联网上获取信息的人通常素质高、学历高。手机捕捉访客密码,配合市场策略,最大限度地发挥这类信息的成功率。客户占上风。3.移动端获取通话和通话记录的成本更低,获得的目标客户的第一手信息程度更是天壤之别。网站对这些代码的访问也将成为用户的无形资产。4、网站市场广阔,客户无限,联通、电信、移动通关,打造国内首个移动客户跟单系统,客户跟单交易汇率暴涨了!!客户跟单成交率暴涨!!客户跟单成交率暴涨!!

爬虫爬取,url地址收录分页信息,这个表单很简单,这个表单使用第三方工具爬取也很简单,基本不用写代码,对我来说,宁愿花半天时间写代码自己懒得学第三方工具的人还是可以自己写代码来的。如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是: 1.通过数据采集软件,通过软件采集网站客户在@>上留下的爬取是爬虫网站爬取的,已经在APP,是通过安装网站中的代码获取的,这些都是通过安装在网站中的代码进行爬取,然后抓取访问者的。其缺点如下。一是只能捕获自己的网站访问者,二是只能被php网站使用,三是涉及客户隐私,容易被检测到通过推广。运营商的大数据可以根据同行提供的网站、app、微信小程序、400电话、固话等获取潜在客户。

然而,智能手机APP尚未成为主流,仅在某些领域有较为成熟的应用,但手机APP智能化已成为不可阻挡的趋势。移动网站还包括 wap 站和应用程序。Wap站一般使用以m开头的域名。在这个域名下,采集JS代码的部署和运行有了新的局面。运营商是否支持部署这么重的 JS,移动浏览器是否支持这些 JS 特性。wap网站比较好,比较复杂的是app。该应用程序没有浏览量的概念,并且大多数应用程序不是HTML格式。在应用程序中我们想要采集什么数据以及如何采集这个数据。采集 的这些数据如何衡量应用的流量。手机APP应用采集的数据,

移动大数据分析也越来越流行。手机APP之所以如此智能,是因为它们是大数据模型支持的大数据背景下的个性化应用。当然,我们也可以将手机APP智能化视为大数据应用的延伸。然而,智能手机APP尚未成为主流,仅在某些领域有较为成熟的应用,但手机APP智能化已成为不可阻挡的趋势。移动网站还包括 wap 站和应用程序。Wap站一般使用以m开头的域名。在这个域名下,采集JS代码的部署和运行有了新的局面。运营商是否支持部署这么重的 JS,移动浏览器是否支持这些 JS 特性。wap网站比较好,更复杂的是应用程序。该应用程序没有浏览量的概念,并且大多数应用程序不是HTML格式。我们想要应用程序 采集 中的哪些数据。

您可以像 采集normal网站 一样 采集App 数据。这里有一些可以使用的专业工具。很多APP通过主动采集数据来改进智能元素的模式。用户数越大,数据采集时间越长,对用户需求的分析越精准,未来的发展趋势必然是主动数据采集、数据采集、移动网站 + 手机APP相互结合,多种方式组合获取和处理数据。数据的用途会越来越多,优采云采集器也在积极研究探索该领域的相关智能实现方式,为企业大数据提供更多便利,让整个互联网+ 移动互联网上的大数据采集变得更简单、更智能。操作员嵌入封装技术。首先,通过运营商自己的后台创建一个简单的h5页面。运营商会将运营商的界面放在这个h5页面中。,然后会形成一个超链接,这个超链接会放置在当前极木鱼/聚棉城网站/微信原生广告/广电通推广/自建网站SEO的后台。

但绝大多数仍然是故意的。直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模数据抓取:主要是拦截同行的实时客户,可以基于网站、APP、400电话、固话、关键词@等方式对实时访客数据进行建模和抓取>等JS代码三网拦截:主要针对自己的网站访客拦截,网站,网页,网站,URL可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。的。

我们可以拦截来电的客户或同行、今日头条、微信等平台,制作落地页进行推广。我们可以实时拦截访问过该页面的客户,垂直行业的APP,如:安居客、土巴兔、瓜子二手车、易信等,我们可以拦截任何地区或任何地区访问过该APP的实时用户。全国各地。比如:比如你是商人,需要一些潜在客户,你只需要提供一些同行的固话,或者是APP,400这样的电话,等等。这时,三打获客系统可以帮你获取客户代码进行营销。大数据营销的四大优势:1.通话和通话记录的获取 当前客户端抓码软件网站 获取通过手机访问网站的实现成功率极高,对于这部分“捕获”的客户用户的开发成功率可想而知。2.获取通话和通话记录。使用网站在手机上获取信息的人。

比如:比如你做生意,需要一些潜在客户,你只需要提供一些同行的固定线路,或者APP,比如400电话等等。这时,三打获客系统可以帮你获取客户代码进行营销。

拨码时,通过系统拨打号码并发送短信进行营销,也就是说卡在下一步,明码转化为暗号。众所周知,大数据营销绝对是未来网络推广营销发展的必然趋势,但如何在保护用户权益和用户隐私的前提下思考和探索。运营商数据,这样运营商就会有一个http报告,每个访问者用自己的4G流量访问了哪些网站APP,并记录了他们消耗了多少流量。这样,我们就可以很好地把握游客的消费行为和预期需求。毫无疑问,开发此类客户的转化率非常高。wap手机网站 获取访客信息系统,可以提高网站的转化率。是企业网站和招标网联盟的商务营销,你可以放心使用。网站访客码获取,比如你在浏览今日头条,我们可以通过浏览今日头条来获取你。

如何采集这个数据。采集 的这些数据如何衡量应用的流量。手机APP应用采集的数据,手机APP其实是通过HTTP协议与之交互的。只要我们分析一下接口地址和参数的含义,就可以像采集普通网站采集App数据。这里有一些可以使用的专业工具。很多APP通过主动采集数据来改进智能元素的模式。用户数越大,数据采集时间越长,对用户需求的分析越精准,未来的发展趋势必然是主动数据采集、数据采集、移动网站 + 手机APP相互结合,多种方式组合获取和处理数据。数据的用途会越来越多,

如何采集这个数据。采集 的这些数据如何衡量应用的流量。手机APP应用采集的数据,手机APP其实是通过HTTP协议与之交互的。只要我们分析一下接口地址和参数的含义,就可以像采集普通网站采集App数据。这里有一些可以使用的专业工具。很多APP通过主动采集数据来改进智能元素的模式。用户数越大,数据采集时间越长,对用户需求的分析越精准,未来的发展趋势必然是主动数据采集、数据采集、移动网站 + 手机APP相互结合,多种方式组合获取和处理数据。数据的用途会越来越多,

2.通话和通话记录的获取网站通过手机在互联网上获取信息的人通常素质高、学历高。手机捕捉访客密码,配合市场策略,最大限度地发挥这类信息的成功率。客户占上风。3.移动端获取通话和通话记录的成本更低,获取的目标客户的第一手信息程度更是天壤之别。网站对这些代码的访问也将成为用户的无形资产。网站进入市场广泛,客户无限,联通、电信、移动通关,打造全国首个移动客户复制系统,客户跟单交易率暴涨!“运营商大数据营销”,您可以从任意网站、APP、手机中直接获取实时访客电话信息。APP下载的用户资料、拨打座机的用户信息、400电话号码,则此操作将侵犯用户隐私。

更聪明的是,运营商埋点封装技术,首先通过运营商自己的后台制作一个简单的h5页面,运营商将运营商的界面放在这个h5页面中,然后形成一个超链接来放置这个超链接。链放在当前极目鱼/巨橙网站/微信原生广告/广电通推广/自建网站SEO的后台。只要有客户点击,运营商就会自动将三个网络的加密数据发送到他们的网站。在呼出的背景下,事后直接与客户沟通是很好的。插入代码,写入自己的网站前端。这种抓取形式只能抓取自己的网站、采集访客人数等数据,均符合采集,不会泄露访客隐私。以上是网站获取的几种方法。掌握这些技术,让推广的网站的访客不会流失,可以降低获客成本,让公司业绩蒸蒸日上。随着总站流量的快速积累,金融企业之间的竞争日趋激烈。

网站对这些代码的访问也将成为用户的无形资产。网站市场广阔,客户无限,联通、电信、移动通关,打造全国首个移动客户跟单系统,客户跟单交易率暴涨!“运营商大数据营销”,您可以从任意网站、APP、手机中直接获取实时访客电话信息。APP下载的用户资料、拨打座机的用户信息、400电话号码,这样的操作会不会侵犯用户隐私?答案是不。因为无论是大数据公司还是使用它的客户都看不到完整的姓名和姓名。在拨码时,通过系统拨打号码并发送短信进行营销,也就是卡在下一步,把明号变成暗号。众所周知,大数据营销绝对是未来网络推广营销发展的必然趋势。,但如何在保护用户权益和保护用户隐私的前提下思考和探索。

然后你可以发短信,等等。客户访问了 网站,但没有咨询或打电话。是因为客户没有意图吗?有这种可能,但更有可能的是网站没有呈现客户需要的产品或服务,导致客户流失。如果真是这样,那客户流失确实是一大损失。这也是我们获取不到用户数据的原因。首先,如果用户使用WiFi上网,我们只能得到路由器的请求,手机信息无法传输到我们的中转站。那么如果用户的网速好,或者用户选择3GNET的方式进行3G上网(这是一种很贵的玩法),我们是拿不到的,所以只能拿4G上网的手机,所以我们的命中率也只有30%-40%左右。几乎 100 个流量可以捕获 20 个数字。很多游客在做投标的时候,一句话也不说,或者干脆咨询一下,然后就跑掉了,往往浪费了大量的广告费用。网站 访客让我们付出了很多代价。

“运营商大数据营销”,您可以从任意网站、APP、手机中直接获取实时访客电话信息。APP下载的用户数据、座机通话用户信息、400个电话号码

getv8hn6

实时抓取网页数据(移动联通运营商大数据建模数据抓取的获客方式是什么)

网站优化 • 优采云 发表了文章 • 0 个评论 • 297 次浏览 • 2022-03-03 01:13

黑龙江省的信息流可以爬取obdl吗?

客户访问网站,但未咨询或致电。是因为客户没有意图吗?有这种可能,但更有可能的是网站没有呈现客户需要的产品或服务,导致客户流失。如果真是这样,那客户流失确实是一大损失。

只要客户点击,运营商就会自动将三网加密后的数据发送到他们的出站后台,然后直接与客户沟通。插入代码,写入自己的网站前端。这种抓取形式只能抓取自己的网站、采集访客人数等数据,均符合采集,不会泄露访客隐私。以上是网站获取的几种方法。掌握这些技术,让推广的网站的访客不会流失,可以降低获客成本,让公司业绩蒸蒸日上。随着总站流量的快速积累和金融企业之间的竞争日趋激烈,用户获取成本不断上升。以消费金融为例,两年前有效用户获客成本超过100元,大大增加了企业的运营成本。大数据正式成立。以运营商大数据超100PB的数据资源池、日处理130TB数据的强大算力、贯穿业务全生命周期的安全体系为前提,服务渠道遍及全国31个省份.

但绝大多数仍然是故意的。直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模数据抓取:主要是拦截同行的实时客户,可以基于网站、APP、400电话、固话、关键词@等方式对实时访客数据进行建模和抓取>等JS代码三网拦截:主要针对自己的网站访客拦截,网站,网页,网站,URL可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。的。

瓜子二手车、易信等,我们可以实时拦截任何地区或全国访问过APP的用户。比如:比如你是商人,需要一些潜在客户,你只需要提供一些同行的固话,或者是APP,400这样的电话,等等。这时,三打获客系统可以帮你获取客户代码进行营销。大数据营销的四大优势:1.通话和通话记录的获取 当前客户端抓码软件网站获取 通过手机访问网站的实现成功率极高这部分“俘获”客户用户的开发成功率可想而知。2.通话和通话记录的采集网站 通过手机在互联网上获取信息的人通常是高素质和高学历的。手机捕捉访客密码,配合市场策略,最大限度地发挥这类信息的成功率。客户占上风。3.获取通话和通话记录的成本更低,而获取目标客户第一手信息的成本更高。

如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是: 1.通过数据采集软件,通过软件采集网站客户在@>上留下的爬取是爬虫网站爬取的,已经在APP,是通过安装网站中的代码获取的,这些都是通过安装在网站中的代码进行爬取,然后抓取访问者的。其缺点如下。一是只能捕获自己的网站访问者,二是只能被php网站使用,三是涉及客户隐私,容易被检测到通过推广。运营商大数据可以基于网站、app、微信小程序、400电话号码、和同行提供的固定电话。与Python不同的是,它不需要在网站中植入代码,运营商的大数据是通过运营商的手机用户在网站和APP中,400电话,400电话,运营商将标记流量或话费,然后对网络进行建模。

可根据网站、APP、400电话、固话、关键词@>等建模抓取实时访客数据。JS代码三网拦截:主要针对自己的网站访问者拦截,网站,网页,网站,URL都可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。只有极少数的10%的人会留下来观看网站,这对企业来说是一种投标投入成本的浪费。企业和公司的大量数据丢失。爬虫爬取,url地址收录分页信息,这个表单很简单,这个表单使用第三方工具爬取也很简单,基本不用写代码,对我来说,

只要你提交这个站点,运营商就会提取在这个网站上消耗流量的用户。这样就实现了网站的捕获,间接实现了营销。应用抓取是一回事。只要标记了所使用的浏览,就会被提交者获取。比如你是家装师,当你能拿到大型装修办公桌的数据时,浏览过这些网站的人不敢说都需要装修,但大部分还是有心的. 直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站 爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模与数据采集:主要是拦截同行的实时客户。

但绝大多数仍然是故意的。直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模数据抓取:主要是拦截同行的实时客户,可以基于网站、APP、400电话、固话、关键词@等方式对实时访客数据进行建模和抓取>等JS代码三网拦截:主要针对自己的网站访客拦截,网站,网页,网站,URL可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。的。只有极少的 10% 的人会留下来观看网站,这对企业来说是对竞价投入成本的浪费。企业和公司的大量数据丢失。

对访问APP超过一分钟的意向客户进行抓拍,因此运营商的大数据不仅限于自己的网站获取客户,任何网站、APP、400电话、固话你可以抓住并得到它。我们是正规运营商,与运营商有深度合作。运营商采集数据并发送给企业,然后提供专门的大数据营销后台供企业调用。网站同行每天有多少客户访问他们的网站,我们可以实时拦截每天频繁访问网站的客户,同行业400个电话,或公司座机,每天有多少客户打电话咨询,我们可以拦截正在通话的客户或同行,今日头条,

移动大数据分析也越来越流行。手机APP之所以如此智能,是因为它们是大数据模型支持的大数据背景下的个性化应用。当然,我们也可以将手机APP智能化视为大数据应用的延伸。然而,智能手机APP尚未成为主流,仅在某些领域有较为成熟的应用,但手机APP智能化已成为不可阻挡的趋势。移动网站还包括 wap 站和应用程序。Wap站一般使用以m开头的域名。在这个域名下,采集JS代码的部署和运行有了新的局面。运营商是否支持部署这么重的 JS,移动浏览器是否支持这些 JS 特性。wap网站比较好,更复杂的是应用程序。该应用程序没有浏览量的概念,并且大多数应用程序不是HTML格式。我们想要应用程序 采集 中的哪些数据。

只有极少的 10% 的人会留下来观看网站,这对企业来说是对竞价投入成本的浪费。企业和公司的大量数据丢失。爬虫爬取,url地址收录分页信息,这个表单很简单,这个表单使用第三方工具爬取也很简单,基本不用写代码,对我来说,宁愿花半天时间写代码自己懒得学第三方工具的人还是可以自己写代码来的。如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是: 1.通过数据采集软件,通过软件采集网站客户在@>上留下的爬取是爬虫网站爬取的,已经在应用程序,并且是通过安装网站中的代码获得的,这些都是通过安装在网站中的代码进行爬取,然后抓取访问者的。缺点如下。一是只能抓自己的网站访问者,二是只能用php网站。

网站同行每天有多少客户访问他们的网站,我们可以实时拦截每天频繁访问网站的客户,同行业400个电话,或公司座机,每天有多少客户来电咨询,我们可以拦截来电或同行,今日头条,微信等平台的客户,并制作登陆页面进行推广,可以拦截访问过的客户实时页面,垂直行业行业APP,如:安居客、土巴兔、瓜子二手车、宜信等。我们可以拦截任何地区或全国访问过该APP的实时用户

getv8hn6 查看全部

实时抓取网页数据(移动联通运营商大数据建模数据抓取的获客方式是什么)

黑龙江省的信息流可以爬取obdl吗?

客户访问网站,但未咨询或致电。是因为客户没有意图吗?有这种可能,但更有可能的是网站没有呈现客户需要的产品或服务,导致客户流失。如果真是这样,那客户流失确实是一大损失。

只要客户点击,运营商就会自动将三网加密后的数据发送到他们的出站后台,然后直接与客户沟通。插入代码,写入自己的网站前端。这种抓取形式只能抓取自己的网站、采集访客人数等数据,均符合采集,不会泄露访客隐私。以上是网站获取的几种方法。掌握这些技术,让推广的网站的访客不会流失,可以降低获客成本,让公司业绩蒸蒸日上。随着总站流量的快速积累和金融企业之间的竞争日趋激烈,用户获取成本不断上升。以消费金融为例,两年前有效用户获客成本超过100元,大大增加了企业的运营成本。大数据正式成立。以运营商大数据超100PB的数据资源池、日处理130TB数据的强大算力、贯穿业务全生命周期的安全体系为前提,服务渠道遍及全国31个省份.

但绝大多数仍然是故意的。直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模数据抓取:主要是拦截同行的实时客户,可以基于网站、APP、400电话、固话、关键词@等方式对实时访客数据进行建模和抓取>等JS代码三网拦截:主要针对自己的网站访客拦截,网站,网页,网站,URL可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。的。

瓜子二手车、易信等,我们可以实时拦截任何地区或全国访问过APP的用户。比如:比如你是商人,需要一些潜在客户,你只需要提供一些同行的固话,或者是APP,400这样的电话,等等。这时,三打获客系统可以帮你获取客户代码进行营销。大数据营销的四大优势:1.通话和通话记录的获取 当前客户端抓码软件网站获取 通过手机访问网站的实现成功率极高这部分“俘获”客户用户的开发成功率可想而知。2.通话和通话记录的采集网站 通过手机在互联网上获取信息的人通常是高素质和高学历的。手机捕捉访客密码,配合市场策略,最大限度地发挥这类信息的成功率。客户占上风。3.获取通话和通话记录的成本更低,而获取目标客户第一手信息的成本更高。

如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是: 1.通过数据采集软件,通过软件采集网站客户在@>上留下的爬取是爬虫网站爬取的,已经在APP,是通过安装网站中的代码获取的,这些都是通过安装在网站中的代码进行爬取,然后抓取访问者的。其缺点如下。一是只能捕获自己的网站访问者,二是只能被php网站使用,三是涉及客户隐私,容易被检测到通过推广。运营商大数据可以基于网站、app、微信小程序、400电话号码、和同行提供的固定电话。与Python不同的是,它不需要在网站中植入代码,运营商的大数据是通过运营商的手机用户在网站和APP中,400电话,400电话,运营商将标记流量或话费,然后对网络进行建模。

可根据网站、APP、400电话、固话、关键词@>等建模抓取实时访客数据。JS代码三网拦截:主要针对自己的网站访问者拦截,网站,网页,网站,URL都可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。只有极少数的10%的人会留下来观看网站,这对企业来说是一种投标投入成本的浪费。企业和公司的大量数据丢失。爬虫爬取,url地址收录分页信息,这个表单很简单,这个表单使用第三方工具爬取也很简单,基本不用写代码,对我来说,

只要你提交这个站点,运营商就会提取在这个网站上消耗流量的用户。这样就实现了网站的捕获,间接实现了营销。应用抓取是一回事。只要标记了所使用的浏览,就会被提交者获取。比如你是家装师,当你能拿到大型装修办公桌的数据时,浏览过这些网站的人不敢说都需要装修,但大部分还是有心的. 直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站 爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模与数据采集:主要是拦截同行的实时客户。

但绝大多数仍然是故意的。直接获客是比你的广告更直接的获客方式,也能省下不少钱。这种网站捕获的获客方式是一种新的营销方式,用好产品为商家解决客户问题。网站爬取当前数据采集、爬虫、算子大数据建模、自己添加JS代码网站等,我只详细介绍后两种方式。移动联通运营商大数据建模数据抓取:主要是拦截同行的实时客户,可以基于网站、APP、400电话、固话、关键词@等方式对实时访客数据进行建模和抓取>等JS代码三网拦截:主要针对自己的网站访客拦截,网站,网页,网站,URL可以实现对访问者的拦截。网站 收购一直是一个热门话题。现实中,我们用了很多方法和推广手段来吸引客户到我们自己的网站,但大多只是看了一眼就匆匆离去。的。只有极少的 10% 的人会留下来观看网站,这对企业来说是对竞价投入成本的浪费。企业和公司的大量数据丢失。

对访问APP超过一分钟的意向客户进行抓拍,因此运营商的大数据不仅限于自己的网站获取客户,任何网站、APP、400电话、固话你可以抓住并得到它。我们是正规运营商,与运营商有深度合作。运营商采集数据并发送给企业,然后提供专门的大数据营销后台供企业调用。网站同行每天有多少客户访问他们的网站,我们可以实时拦截每天频繁访问网站的客户,同行业400个电话,或公司座机,每天有多少客户打电话咨询,我们可以拦截正在通话的客户或同行,今日头条,

移动大数据分析也越来越流行。手机APP之所以如此智能,是因为它们是大数据模型支持的大数据背景下的个性化应用。当然,我们也可以将手机APP智能化视为大数据应用的延伸。然而,智能手机APP尚未成为主流,仅在某些领域有较为成熟的应用,但手机APP智能化已成为不可阻挡的趋势。移动网站还包括 wap 站和应用程序。Wap站一般使用以m开头的域名。在这个域名下,采集JS代码的部署和运行有了新的局面。运营商是否支持部署这么重的 JS,移动浏览器是否支持这些 JS 特性。wap网站比较好,更复杂的是应用程序。该应用程序没有浏览量的概念,并且大多数应用程序不是HTML格式。我们想要应用程序 采集 中的哪些数据。

只有极少的 10% 的人会留下来观看网站,这对企业来说是对竞价投入成本的浪费。企业和公司的大量数据丢失。爬虫爬取,url地址收录分页信息,这个表单很简单,这个表单使用第三方工具爬取也很简单,基本不用写代码,对我来说,宁愿花半天时间写代码自己懒得学第三方工具的人还是可以自己写代码来的。如今,运营商的大数据参差不齐。市场上有多种形式的收购和捕获。原来是: 1.通过数据采集软件,通过软件采集网站客户在@>上留下的爬取是爬虫网站爬取的,已经在应用程序,并且是通过安装网站中的代码获得的,这些都是通过安装在网站中的代码进行爬取,然后抓取访问者的。缺点如下。一是只能抓自己的网站访问者,二是只能用php网站。

网站同行每天有多少客户访问他们的网站,我们可以实时拦截每天频繁访问网站的客户,同行业400个电话,或公司座机,每天有多少客户来电咨询,我们可以拦截来电或同行,今日头条,微信等平台的客户,并制作登陆页面进行推广,可以拦截访问过的客户实时页面,垂直行业行业APP,如:安居客、土巴兔、瓜子二手车、宜信等。我们可以拦截任何地区或全国访问过该APP的实时用户

getv8hn6

实时抓取网页数据( 在线声誉管理的主要优势:监控在线评论的优势)

网站优化 • 优采云 发表了文章 • 0 个评论 • 100 次浏览 • 2022-02-27 01:06

在线声誉管理的主要优势:监控在线评论的优势)

一项深入研究发现,80% 的互联网用户认为互联网是最可靠的产品和公司信息来源。另一项研究还声称,大约 85% 的互联网用户通常将在线评论称为个人推荐或朋友的意见。

让品牌声誉不受管理不是正确的选择。数字营销机构和在线声誉管理公司可以帮助企业处理不同的问题,并在数字世界中建立良好的品牌形象。

在本文中,我们将概述什么是在线声誉管理、它的工作原理以及它为何如此重要。此外,我们将关注监控部分以及如何利用数据中心代理或现成的网络抓取 API 来促进数据采集过程。

什么是在线声誉管理?

在线声誉管理 (ORM) 将营销、公关和客户服务相结合,为个人、品牌和企业创造和维持积极的在线形象。

互联网声誉管理的概念包括监控和回应所有来自客户的负面评论,及时回应网上涉及企业的负面帖子,以及及时发布适当的公开声明。

由于评论可以极大地影响搜索排名,因此在线声誉管理侧重于主动监控和管理服务或产品的搜索引擎结果。

为什么在线声誉管理如此重要?

ORM的重点是确保品牌的声誉不受百度或其他主流搜索引擎的算法影响。这些算法无法正确区分真实信息和误导性信息,因此无法用于正确建立或维持良好的在线声誉。

在线声誉管理的主要优势如下:

在线声誉管理如何运作?

在线声誉管理是对品牌或产品在互联网上的形象的控制。控制在线评论可以通过以下步骤完成:广泛的研究、战略制定和战略执行。

重要的是要注意,这个过程是连续的,永远不会结束。随着数字环境的不断变化,在线监控公司需要定期和持续的监控来更新和升级客户的策略。

监控在线声誉的挑战

在进行网络搜索时,ORM 公司在处理海量网络数据时会遇到各种障碍。以下是监控品牌在线形象时最常见的一些挑战:

高效在线监控解决方案

有效的在线监控涵盖了从数据采集到正确处理的流程的每个部分。然而,从无数网站s中采集数据并不容易。通常,数字营销机构或在线声誉公司要么建立内部网络抓取工具,要么选择现成的数据采集工具来进行有效的数据监控和采集。

总结

信任是品牌形象的一个非常重要的因素,建立积极的在线形象可以有效避免很多麻烦。监控网络上的复杂信息需要采集大量数据,在线声誉管理公司会根据具体需求和目标开发合适的网络抓取解决方案。对于内部抓取专家和开发人员组成的专门团队,数据中心代理无疑会提高成功率并有助于改善网络抓取体验。如果您想了解更多,可以查看我们的文章,或随时访问我们的网站联系客服,我们将竭诚为您服务。 查看全部

实时抓取网页数据(

在线声誉管理的主要优势:监控在线评论的优势)

一项深入研究发现,80% 的互联网用户认为互联网是最可靠的产品和公司信息来源。另一项研究还声称,大约 85% 的互联网用户通常将在线评论称为个人推荐或朋友的意见。