实时抓取网页数据

实时抓取网页数据( Python查看股市信息太过招摇决定Python抓取相关信息小巧便捷)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-10-04 09:36

Python查看股市信息太过招摇决定Python抓取相关信息小巧便捷)

Python爬取网页数据python爬取网页数据txt51自信是取之不尽的源泉自信是无尽的波浪,自信是快速进步的通道,自信是成功之母,用python爬取网页并处理它们 2009-02- 19150950 Category Python tag no font size subscription 主要目的是抓取网页的源代码,处理其中需要的数据,并保存到数据库中。它已实现抓取页面并读取数据。第一步抓取页面。这一步很简单,引入 urllib 使用 urlopen 打开 URL,使用 read 方法读取数据。为了方便测试,使用本地文本文件,而不是抓取网页。第二步。处理数据。如果页面代码更加规范和规范,可以使用HTMLParser进行简单处理,但具体情况需要具体分析。最好使用常规规则。顺便练习一下刚学的正则表达式。其实正则表达式也是一种比较简单的语言。符号比较晦涩难懂。它只能是更多的练习和练习。Step 3 将处理后的数据保存到数据库中,使用pymssql进行处理。只需将其保存到文本文件并扩展即可。使用此功能,您还可以捕获整个 网站 图像并自动声明站点地图文件。接下来的任务是研究python的socket函数 --codinggbk--importurllibimportrepagerurlliburlopendatapagerreadpagerclosefopenr"D2txt"datafreadfclose 处理数据预编译classonedivreIreSmpfindalldatas"

链接地址 p_titlerecompileh2h2reIreSp_urlrecompilehref"reIreSp_summarrecompileppreIreSp_imagerecompileeshopimages"reIreSss" title "p_titlesearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup51327n""介绍"p_summarsearchdatangroup51327n" 的相关脚本也决定了将python的相关信息写入脚本中信息。它小巧方便。1 先写一个Python脚本抓取股市查询页面。这很简单。我发现个股的实时行情数据是写在一个javascript文件里的。2 Extract this 编写javascript文件URL,编写一个Python脚本来抓取文件,读取其内容,做字符串处理,提取股价上涨等信息。以“股票代码js”形式解析文件名创建配置文件,提供感兴趣的股票代码。使用 Python 脚本读取配置信息。定期阅读所需的实时信息。5 定义每日市场格式并将其存储为 XML 格式。脚本实现读取存储的行情信息,生成报表K线等图形信息 查看全部

实时抓取网页数据(

Python查看股市信息太过招摇决定Python抓取相关信息小巧便捷)

Python爬取网页数据python爬取网页数据txt51自信是取之不尽的源泉自信是无尽的波浪,自信是快速进步的通道,自信是成功之母,用python爬取网页并处理它们 2009-02- 19150950 Category Python tag no font size subscription 主要目的是抓取网页的源代码,处理其中需要的数据,并保存到数据库中。它已实现抓取页面并读取数据。第一步抓取页面。这一步很简单,引入 urllib 使用 urlopen 打开 URL,使用 read 方法读取数据。为了方便测试,使用本地文本文件,而不是抓取网页。第二步。处理数据。如果页面代码更加规范和规范,可以使用HTMLParser进行简单处理,但具体情况需要具体分析。最好使用常规规则。顺便练习一下刚学的正则表达式。其实正则表达式也是一种比较简单的语言。符号比较晦涩难懂。它只能是更多的练习和练习。Step 3 将处理后的数据保存到数据库中,使用pymssql进行处理。只需将其保存到文本文件并扩展即可。使用此功能,您还可以捕获整个 网站 图像并自动声明站点地图文件。接下来的任务是研究python的socket函数 --codinggbk--importurllibimportrepagerurlliburlopendatapagerreadpagerclosefopenr"D2txt"datafreadfclose 处理数据预编译classonedivreIreSmpfindalldatas"

链接地址 p_titlerecompileh2h2reIreSp_urlrecompilehref"reIreSp_summarrecompileppreIreSp_imagerecompileeshopimages"reIreSss" title "p_titlesearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup51327n""介绍"p_summarsearchdatangroup51327n" 的相关脚本也决定了将python的相关信息写入脚本中信息。它小巧方便。1 先写一个Python脚本抓取股市查询页面。这很简单。我发现个股的实时行情数据是写在一个javascript文件里的。2 Extract this 编写javascript文件URL,编写一个Python脚本来抓取文件,读取其内容,做字符串处理,提取股价上涨等信息。以“股票代码js”形式解析文件名创建配置文件,提供感兴趣的股票代码。使用 Python 脚本读取配置信息。定期阅读所需的实时信息。5 定义每日市场格式并将其存储为 XML 格式。脚本实现读取存储的行情信息,生成报表K线等图形信息

实时抓取网页数据( 网络中获取网页数据的案例代码postedon2011-05-31)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-10-03 04:01

网络中获取网页数据的案例代码postedon2011-05-31)

十六、从网上获取网页数据

从网络获取网页数据时,网页可以使用GZIP压缩技术对网页进行压缩,这样可以减少网络传输的数据量,提高浏览速度。所以获取网络数据时需要判断,并使用GZIPInputStream对GZIP格式数据进行特殊处理,否则获取数据时可能出现乱码。

以下是获取网络中网页数据的案例代码

package com.ljq.test;

import java.io.ByteArrayOutputStream;

import java.io.InputStream;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.zip.GZIPInputStream;

import java.util.zip.GZIPOutputStream;

/**

* 从网络中获取网页数据

*

* @author jiqinlin

*

*/

public class InternetTest2 {

@SuppressWarnings("static-access")

public static void main(String[] args) throws Exception {

String result = "";

//URL url = new URL("http://www.sohu.com");

URL url = new URL("http://www.ku6.com/");

HttpURLConnection conn = (HttpURLConnection) url.openConnection();

conn.setConnectTimeout(6* 1000);//设置连接超时

if (conn.getResponseCode() != 200) throw new RuntimeException("请求url失败");

InputStream is = conn.getInputStream();//得到网络返回的输入流

if("gzip".equals(conn.getContentEncoding())){

result = new InternetTest2().readDataForZgip(is, "GBK");

}else {

result = new InternetTest2().readData(is, "GBK");

}

conn.disconnect();

System.out.println(result);

System.err.println("ContentEncoding: " + conn.getContentEncoding());

}

//第一个参数为输入流,第二个参数为字符集编码

public static String readData(InputStream inSream, String charsetName) throws Exception{

ByteArrayOutputStream outStream = new ByteArrayOutputStream();

byte[] buffer = new byte[1024];

int len = -1;

while( (len = inSream.read(buffer)) != -1 ){

outStream.write(buffer, 0, len);

}

byte[] data = outStream.toByteArray();

outStream.close();

inSream.close();

return new String(data, charsetName);

}

//第一个参数为输入流,第二个参数为字符集编码

public static String readDataForZgip(InputStream inStream, String charsetName) throws Exception{

GZIPInputStream gzipStream = new GZIPInputStream(inStream);

ByteArrayOutputStream outStream = new ByteArrayOutputStream();

byte[] buffer =new byte[1024];

int len = -1;

while ((len = gzipStream.read(buffer))!=-1) {

outStream.write(buffer, 0, len);

}

byte[] data = outStream.toByteArray();

outStream.close();

gzipStream.close();

inStream.close();

return new String(data, charsetName);

}

}

发表于 2011-05-31 15:40 无情阅读(3891)评论(2)编辑 查看全部

实时抓取网页数据(

网络中获取网页数据的案例代码postedon2011-05-31)

十六、从网上获取网页数据

从网络获取网页数据时,网页可以使用GZIP压缩技术对网页进行压缩,这样可以减少网络传输的数据量,提高浏览速度。所以获取网络数据时需要判断,并使用GZIPInputStream对GZIP格式数据进行特殊处理,否则获取数据时可能出现乱码。

以下是获取网络中网页数据的案例代码

package com.ljq.test;

import java.io.ByteArrayOutputStream;

import java.io.InputStream;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.zip.GZIPInputStream;

import java.util.zip.GZIPOutputStream;

/**

* 从网络中获取网页数据

*

* @author jiqinlin

*

*/

public class InternetTest2 {

@SuppressWarnings("static-access")

public static void main(String[] args) throws Exception {

String result = "";

//URL url = new URL("http://www.sohu.com";);

URL url = new URL("http://www.ku6.com/";);

HttpURLConnection conn = (HttpURLConnection) url.openConnection();

conn.setConnectTimeout(6* 1000);//设置连接超时

if (conn.getResponseCode() != 200) throw new RuntimeException("请求url失败");

InputStream is = conn.getInputStream();//得到网络返回的输入流

if("gzip".equals(conn.getContentEncoding())){

result = new InternetTest2().readDataForZgip(is, "GBK");

}else {

result = new InternetTest2().readData(is, "GBK");

}

conn.disconnect();

System.out.println(result);

System.err.println("ContentEncoding: " + conn.getContentEncoding());

}

//第一个参数为输入流,第二个参数为字符集编码

public static String readData(InputStream inSream, String charsetName) throws Exception{

ByteArrayOutputStream outStream = new ByteArrayOutputStream();

byte[] buffer = new byte[1024];

int len = -1;

while( (len = inSream.read(buffer)) != -1 ){

outStream.write(buffer, 0, len);

}

byte[] data = outStream.toByteArray();

outStream.close();

inSream.close();

return new String(data, charsetName);

}

//第一个参数为输入流,第二个参数为字符集编码

public static String readDataForZgip(InputStream inStream, String charsetName) throws Exception{

GZIPInputStream gzipStream = new GZIPInputStream(inStream);

ByteArrayOutputStream outStream = new ByteArrayOutputStream();

byte[] buffer =new byte[1024];

int len = -1;

while ((len = gzipStream.read(buffer))!=-1) {

outStream.write(buffer, 0, len);

}

byte[] data = outStream.toByteArray();

outStream.close();

gzipStream.close();

inStream.close();

return new String(data, charsetName);

}

}

发表于 2011-05-31 15:40 无情阅读(3891)评论(2)编辑

实时抓取网页数据(网页数据抓取哪种方法?(要最详细的))

网站优化 • 优采云 发表了文章 • 0 个评论 • 102 次浏览 • 2021-10-03 00:06

哪种方法爬取网页数据最快?(要最详细)

在网络上获取数据的方式有哪些?

主要是ajax获取数据,当然也可以通过websocket获取数据。其中,ajax是最主要的获取数据的方式。界面写在后台。前端今天发来CSS布局HTML编辑器获取后台返回的数据,然后通过js解析并渲染到页面上。Websocket 也可以获取数据。

如何从网站或者软件网站中抓取数据是BS架构,软件是CS架构。目前爬虫工具和软件机器人工具可以抓取软件中网站的数据。如果是,则暂时无法实施爬虫。软件机器人帮派工具可以抓取界面上的数据。界面上不可见的事情做不到采集。

可以用php完成,但是需要很多代码。说实话,我没有写那么多代码的动力……也许流程是先拿到你发送的URL中收录的URL,然后循环,再抓取里面的URL再循环。获取内容的原因很简单。

WebClient MyWebClient = new WebClient(); MyWebClient.Credentials = CredentialCache.DefaultCredentials; //获取或设置互联网资源的CSS布局HTML编辑器,今天与大家分享认证的网络凭证Byte[] pageData = MyWebClient. 下载数据(tbUrl.Text); //从指定的

有什么好的办法可以更好的获取网页上的表格数据吗?

可以通过Excel中获取外部数据的功能来实现。具体操作如下:

选择您要从中获取数据的网站(并非所有网站都可以获取您想要的数据),然后复制完整的网站。本站已保留

打开 Excel,单击数据选项卡,然后选择获取外部数据 - 从网站按钮。

应该使用什么方法从 Excel 等网页中捕获数据?在Excel“数据”选项中,有“获取外部数据”和“来自网站”,只需按照相应步骤“导入”即可。

如何获取网页上的数据

编辑软件获取网页上的数据,分几步写出软件和什么知识,有没有上传图片的这一面,如果不上传图片,路径是你本地的路径,以及要在网络上使用,必须先上传。替换所有本地路径后,如果不知道如何在DW中查看源文件(也就是你说的HTML),可以按F12预览,然后在网页上点击【返回键-】查看源文件]

什么是网页数据抓取?它是获取网页的一些数据,一些是获取有关网页内容的一些信息,还有一些是获取有关您浏览的一些信息。事件信息、点击信息等 查看全部

实时抓取网页数据(网页数据抓取哪种方法?(要最详细的))

哪种方法爬取网页数据最快?(要最详细)

在网络上获取数据的方式有哪些?

主要是ajax获取数据,当然也可以通过websocket获取数据。其中,ajax是最主要的获取数据的方式。界面写在后台。前端今天发来CSS布局HTML编辑器获取后台返回的数据,然后通过js解析并渲染到页面上。Websocket 也可以获取数据。

如何从网站或者软件网站中抓取数据是BS架构,软件是CS架构。目前爬虫工具和软件机器人工具可以抓取软件中网站的数据。如果是,则暂时无法实施爬虫。软件机器人帮派工具可以抓取界面上的数据。界面上不可见的事情做不到采集。

可以用php完成,但是需要很多代码。说实话,我没有写那么多代码的动力……也许流程是先拿到你发送的URL中收录的URL,然后循环,再抓取里面的URL再循环。获取内容的原因很简单。

WebClient MyWebClient = new WebClient(); MyWebClient.Credentials = CredentialCache.DefaultCredentials; //获取或设置互联网资源的CSS布局HTML编辑器,今天与大家分享认证的网络凭证Byte[] pageData = MyWebClient. 下载数据(tbUrl.Text); //从指定的

有什么好的办法可以更好的获取网页上的表格数据吗?

可以通过Excel中获取外部数据的功能来实现。具体操作如下:

选择您要从中获取数据的网站(并非所有网站都可以获取您想要的数据),然后复制完整的网站。本站已保留

打开 Excel,单击数据选项卡,然后选择获取外部数据 - 从网站按钮。

应该使用什么方法从 Excel 等网页中捕获数据?在Excel“数据”选项中,有“获取外部数据”和“来自网站”,只需按照相应步骤“导入”即可。

如何获取网页上的数据

编辑软件获取网页上的数据,分几步写出软件和什么知识,有没有上传图片的这一面,如果不上传图片,路径是你本地的路径,以及要在网络上使用,必须先上传。替换所有本地路径后,如果不知道如何在DW中查看源文件(也就是你说的HTML),可以按F12预览,然后在网页上点击【返回键-】查看源文件]

什么是网页数据抓取?它是获取网页的一些数据,一些是获取有关网页内容的一些信息,还有一些是获取有关您浏览的一些信息。事件信息、点击信息等

实时抓取网页数据(本文某个站点对数据的显示方式略有不同演示(1)_抓取原网页数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 194 次浏览 • 2021-10-03 00:03

原文链接:

有时出于各种原因,我们需要从某个站点采集数据,但因为不同站点显示的数据略有不同。

本文使用Java向大家展示如何抓取网站数据:(1)抓取原创网页数据;(2)抓取网页Javascript返回的数据。

一、 抓取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页。然后输入IP:111.142.55.73。单击查询按钮。您将能够看到网页上显示的结果:

第二步:查看网页源代码。我们在源码中看到这么一段:

从这里可以看到。再次请求网页后显示查询结果。

查询后看网页地址:

换句话说。我们只想访问一个看起来像这样的网站。可以得到ip查询的结果,然后看代码:

public void captureHtml(String ip) throws Exception {

String strURL = "http://ip.chinaz.com/?

IP=" + ip; URL url = new URL(strURL); HttpURLConnection httpConn = (HttpURLConnection) url.openConnection(); InputStreamReader input = new InputStreamReader(httpConn .getInputStream(), "utf-8"); BufferedReader bufReader = new BufferedReader(input); String line = ""; StringBuilder contentBuf = new StringBuilder(); while ((line = bufReader.readLine()) != null) {contentBuf.append(line);} String buf = contentBuf.toString( ); int beginIx = buf.indexOf("查询结果["); int endIx = buf.indexOf("以上四项依次显示"); String result = buf.substring(beginIx, endIx); System.out . println("captureHtml() 结果:\n" + 结果);}

使用HttpURLConnection连接站点,使用bufReader保存网页返回的数据,然后通过自己定义的解析方法显示结果。

这里我只是随便解析了一下,想要解析准确,就需要自己处理了。

分析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建省漳州市手机

二、 抓取网页的 JavaScript 返回的结果。

有时网站是为了保护自己的数据。网页的源代码中没有直接返回数据。而是采用异步方式用JS返回数据,避免了搜索引擎等工具对网站数据的抓取。

首先看这个页面:

使用第一种方法查看页面的源代码。但是没有找到运单的跟踪信息,因为是通过JS获取的结果。

但是有时候我们非常需要获取JS数据,这个时候我们该怎么办呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以拦截Http的交互内容,我们使用这个工具来达到我们的目的。

先点击开始按钮后,它开始监控网页的交互行为。

我们打开网页:,可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便的查看JS的结果。我们先清除这些数据,然后输入快递号: 7.点击查询按钮,然后查看HTTP Analyzer的结果:

这是在单击查询按钮之后。HTTP Analyzer的结果,我们继续查看:

从上两图可以看出,HTTP Analyzer可以拦截JS返回的数据,并在Response Content中展示。同时可以看到JS请求的网页地址。

在这种情况下,我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为就可以得到数据。即我们只需要访问JS请求的网页地址即可获取数据。当然,前提是数据没有加密。我们记下JS请求的URL:

文=7&频道=&rnd=0

然后让程序请求这个页面的结果!

这是代码:

public void captureJavascript(String postid) throws Exception {

String strURL = "http://www.kiees.cn/sf.php?

wen=" + postid + "&channel=&rnd=0"; URL url = new URL(strURL); HttpURLConnection httpConn = (HttpURLConnection) url.openConnection(); InputStreamReader input = new InputStreamReader(httpConn .getInputStream(), "utf- 8"); BufferedReader bufReader = new BufferedReader(input); String line = ""; StringBuilder contentBuf = new StringBuilder(); while ((line = bufReader.readLine()) != null) {contentBuf.append(line); } System.out.println("captureJavascript():\n" + contentBuf.toString()的结果);}

可以看到,抓取JS的方式和抓取原创网页的代码完全一样,只是做了一个解析JS的过程。

下面是程序运行的结果:

captureJavascript() 的结果:

运单跟踪信息 [7]

这些数据就是JS返回的结果,我们的目的就达到了!

希望这能成为一个需要帮助的孩子,需要程序的源代码。点击这里下载! 查看全部

实时抓取网页数据(本文某个站点对数据的显示方式略有不同演示(1)_抓取原网页数据)

原文链接:

有时出于各种原因,我们需要从某个站点采集数据,但因为不同站点显示的数据略有不同。

本文使用Java向大家展示如何抓取网站数据:(1)抓取原创网页数据;(2)抓取网页Javascript返回的数据。

一、 抓取原创网页。

在这个例子中,我们将从上面获取 ip 查询的结果:

第一步:打开这个网页。然后输入IP:111.142.55.73。单击查询按钮。您将能够看到网页上显示的结果:

第二步:查看网页源代码。我们在源码中看到这么一段:

从这里可以看到。再次请求网页后显示查询结果。

查询后看网页地址:

换句话说。我们只想访问一个看起来像这样的网站。可以得到ip查询的结果,然后看代码:

public void captureHtml(String ip) throws Exception {

String strURL = "http://ip.chinaz.com/?

IP=" + ip; URL url = new URL(strURL); HttpURLConnection httpConn = (HttpURLConnection) url.openConnection(); InputStreamReader input = new InputStreamReader(httpConn .getInputStream(), "utf-8"); BufferedReader bufReader = new BufferedReader(input); String line = ""; StringBuilder contentBuf = new StringBuilder(); while ((line = bufReader.readLine()) != null) {contentBuf.append(line);} String buf = contentBuf.toString( ); int beginIx = buf.indexOf("查询结果["); int endIx = buf.indexOf("以上四项依次显示"); String result = buf.substring(beginIx, endIx); System.out . println("captureHtml() 结果:\n" + 结果);}

使用HttpURLConnection连接站点,使用bufReader保存网页返回的数据,然后通过自己定义的解析方法显示结果。

这里我只是随便解析了一下,想要解析准确,就需要自己处理了。

分析结果如下:

captureHtml() 的结果:

查询结果[1]:111.142.55.73 ==>> 1871591241 ==>> 福建省漳州市手机

二、 抓取网页的 JavaScript 返回的结果。

有时网站是为了保护自己的数据。网页的源代码中没有直接返回数据。而是采用异步方式用JS返回数据,避免了搜索引擎等工具对网站数据的抓取。

首先看这个页面:

使用第一种方法查看页面的源代码。但是没有找到运单的跟踪信息,因为是通过JS获取的结果。

但是有时候我们非常需要获取JS数据,这个时候我们该怎么办呢?

这时候我们就需要用到一个工具:HTTP Analyzer,这个工具可以拦截Http的交互内容,我们使用这个工具来达到我们的目的。

先点击开始按钮后,它开始监控网页的交互行为。

我们打开网页:,可以看到HTTP Analyzer列出了网页的所有请求数据和结果:

为了更方便的查看JS的结果。我们先清除这些数据,然后输入快递号: 7.点击查询按钮,然后查看HTTP Analyzer的结果:

这是在单击查询按钮之后。HTTP Analyzer的结果,我们继续查看:

从上两图可以看出,HTTP Analyzer可以拦截JS返回的数据,并在Response Content中展示。同时可以看到JS请求的网页地址。

在这种情况下,我们只需要分析HTTP Analyzer的结果,然后模拟JS的行为就可以得到数据。即我们只需要访问JS请求的网页地址即可获取数据。当然,前提是数据没有加密。我们记下JS请求的URL:

文=7&频道=&rnd=0

然后让程序请求这个页面的结果!

这是代码:

public void captureJavascript(String postid) throws Exception {

String strURL = "http://www.kiees.cn/sf.php?

wen=" + postid + "&channel=&rnd=0"; URL url = new URL(strURL); HttpURLConnection httpConn = (HttpURLConnection) url.openConnection(); InputStreamReader input = new InputStreamReader(httpConn .getInputStream(), "utf- 8"); BufferedReader bufReader = new BufferedReader(input); String line = ""; StringBuilder contentBuf = new StringBuilder(); while ((line = bufReader.readLine()) != null) {contentBuf.append(line); } System.out.println("captureJavascript():\n" + contentBuf.toString()的结果);}

可以看到,抓取JS的方式和抓取原创网页的代码完全一样,只是做了一个解析JS的过程。

下面是程序运行的结果:

captureJavascript() 的结果:

运单跟踪信息 [7]

这些数据就是JS返回的结果,我们的目的就达到了!

希望这能成为一个需要帮助的孩子,需要程序的源代码。点击这里下载!

实时抓取网页数据(实时抓取网页数据?看看究竟是怎么实现的?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 91 次浏览 • 2021-10-02 19:05

实时抓取网页数据?例如:这个时候你发现:同一段网页链接可以在不同浏览器内打开是多么令人发指的错误提示。最终导致你花了大量时间在webmaster,rewrite-inf的阶段。好不容易我爬取到你的数据了,结果才发现你用了某个存储在java数据库的反爬虫机制。没错,你不是在玩我,就是你在玩我。现在我不仅要调试这个,更要调试你,看看究竟是怎么实现的。

-poweredby看一下正则表达式(因为你使用了正则表达式实现,所以写起来会更加的直观。但由于java的反爬虫机制,正则表达式也不好破解,以下内容请谨慎阅读。)xxx/file/*xxx/file.java你既然去找他,那就是要调试这个java代码的,所以你现在正在调试java-preprocessor你必须创建一个proxy类型的proxy对象,这个proxy对象必须放到proxy类型的变量中,你可以去这个类的方法属性中看。

同样的他也可以proxy。用来去抓包以下数据。注意:当我们访问的网站与googlechrome浏览器进行了一个tcp连接时,服务器会连接到数据库,所以在googlechrome浏览器中,我们并没有get数据的success状态,这时我们就需要用到我们的正则表达式,来获取你需要的数据。一:正则表达式scrapy的三种正则表达式:1.2.3.二:环境搭建$pipinstallpymysqlpymysql--install$pipinstallportal$pipinstallpymytest三:爬虫学习部分python爬虫三步曲:(。

1)获取apikey

2)获取jsonkey

3)获取本地文件 查看全部

实时抓取网页数据(实时抓取网页数据?看看究竟是怎么实现的?(一))

实时抓取网页数据?例如:这个时候你发现:同一段网页链接可以在不同浏览器内打开是多么令人发指的错误提示。最终导致你花了大量时间在webmaster,rewrite-inf的阶段。好不容易我爬取到你的数据了,结果才发现你用了某个存储在java数据库的反爬虫机制。没错,你不是在玩我,就是你在玩我。现在我不仅要调试这个,更要调试你,看看究竟是怎么实现的。

-poweredby看一下正则表达式(因为你使用了正则表达式实现,所以写起来会更加的直观。但由于java的反爬虫机制,正则表达式也不好破解,以下内容请谨慎阅读。)xxx/file/*xxx/file.java你既然去找他,那就是要调试这个java代码的,所以你现在正在调试java-preprocessor你必须创建一个proxy类型的proxy对象,这个proxy对象必须放到proxy类型的变量中,你可以去这个类的方法属性中看。

同样的他也可以proxy。用来去抓包以下数据。注意:当我们访问的网站与googlechrome浏览器进行了一个tcp连接时,服务器会连接到数据库,所以在googlechrome浏览器中,我们并没有get数据的success状态,这时我们就需要用到我们的正则表达式,来获取你需要的数据。一:正则表达式scrapy的三种正则表达式:1.2.3.二:环境搭建$pipinstallpymysqlpymysql--install$pipinstallportal$pipinstallpymytest三:爬虫学习部分python爬虫三步曲:(。

1)获取apikey

2)获取jsonkey

3)获取本地文件

实时抓取网页数据(LinkedIn内部的数据基础设施的演变,你知道几个?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-09-30 21:20

在去年的架构师峰会上,来自LinkedIn的高级软件工程师高磊发表了题为“LinkedIn的数据处理架构”的演讲,重点介绍了LinkedIn内部数据基础设施的演进,包括Databus数据总线项目。当时引起了很多人的好奇。前不久,LinkedIn工程团队的官方博客宣布Databus项目开源。

在互联网架构中,数据系统通常被划分为数据源系统,作为基础数据库来存储用户生成的写操作;并派生数据库或索引以提供读取和其他复杂查询操作。后者往往来源于独立的数据存储,对其中的数据进行变换,有时还包括复杂的业务逻辑处理。缓存中的数据也来自主数据存储。当主数据存储发生变化时,缓存中的数据需要刷新或失效。

LinkedIn内部有很多专用的数据存储和服务系统,形成了一个多元化的生态系统。基本的 OLTP 数据存储用于处理面向用户的写操作和部分读操作。其他专用系统提供负责任的查询,或使用缓存来加速查询结果。因此,整个生态系统需要一个可靠的、支持事务的、一致的数据变更捕获系统。

Databus 是一种实时低延迟数据捕获系统。从2005年开始开发,2011年在LinkedIn上正式进入生产系统。

在 Databus 的 Github 页面上,他们介绍了他们选择当前解决方案的决策过程。

有两种常见的方法来处理这种需求:

应用驱动双向写:在这种模式下,应用层同时向数据库和另一个消息系统发起写操作。这个实现看起来很简单,因为写入数据库的应用程序代码是可以控制的。但是会引入一致性问题,因为没有复杂的协调协议(比如两阶段提交协议或者paxos算法),所以当出现问题时,很难保证数据库和消息系统完全锁定相同的状态。两个系统需要准确完成相同的写操作,并以相同的顺序完成序列化。如果写操作是有条件的或者有部分更新语义,那么事情会变得更加麻烦。

数据库日志挖掘:将数据库作为真实数据的唯一来源,从事务或提交日志中提取更改。这样可以解决一致性问题,但是很难实现,因为Oracle、MySQL等数据库有私有事务日志格式和复制冗余方案,版本升级后很难保证可用性。由于解决方案是处理由应用程序代码发起的数据更改,然后将它们写入另一个数据库,因此冗余系统必须是用户级的并且独立于源。对于瞬息万变的科技公司来说,这种与数据源的独立性对于避免应用程序堆栈的技术锁定或绑定到二进制格式非常重要。

在评估了两种方法的优缺点后,我们决定选择日志挖掘,以一致性和单一事实来源为最高优先级,而不是易于实施。

Databus 传输层的端到端延迟为微秒。每个服务器每秒可以处理数千个数据吞吐量更改事件。它还支持无限回溯能力和丰富的变更订阅功能。大纲结构如下图所示。

从图中可以看出,Search Index 和 Read Replicas 等系统是 Databus 的消费者。当主OLTP数据库发生写操作时,与其相连的中继系统会将数据拉取到中继。在搜索索引或缓存中签入的数据总线消费者客户端将从中继中提取数据并更新索引或缓存。

数据总线提供以下功能:

上图介绍了Databus系统的组成,包括中继、引导服务和客户端库。Bootstrap 服务包括 Bootstrap Producer 和 Bootstrap Server。快速变化的消费者直接从 Relay 获取事件。如果消费者的数据更新明显滞后,那么它需要的数据不在 Relay 日志中,而是在 Bootstrap Producer 中。提交给它的数据将是自消费者上次处理更改以来所有数据更改的快照。

数据总线继电器的功能主要包括:

从数据总线源读取更改的行并将它们序列化为内存缓存中的数据总线更改事件。侦听来自 Databus 客户端(包括 Bootstrap Producer)的请求并传输新的 Databus 数据更改事件。

Databus客户端的功能主要包括:

在Relay上查看新的数据变化事件,执行具体业务逻辑的回调。如果 Relay 太落后,则向 Bootstrap Server 发起查询。新的Databus客户端会向Bootstrap Server发起bootstrap启动查询,然后切换到relay发起查询。为了完成最新的数据变化事件,单个客户端可以处理整个Databus数据流,也可以成为消费者集群的一部分,每个消费者只处理部分流数据

Databus Bootstrap Producer只是一个特定的Databus客户端,它的功能是:

检查中继上的新数据更改事件 将更改存储在 MySQL 数据库 MySQL 数据库中以供 Bootstrap 和客户端使用

Databus Bootstrap Server 的主要功能是监听来自Databus 客户端的请求,并返回长期追溯的数据变化事件。

在LinkedIn上,Databus支持的系统有:

对Databus项目感兴趣的同学可以到Github查看更多信息和相关源码。 查看全部

实时抓取网页数据(LinkedIn内部的数据基础设施的演变,你知道几个?)

在去年的架构师峰会上,来自LinkedIn的高级软件工程师高磊发表了题为“LinkedIn的数据处理架构”的演讲,重点介绍了LinkedIn内部数据基础设施的演进,包括Databus数据总线项目。当时引起了很多人的好奇。前不久,LinkedIn工程团队的官方博客宣布Databus项目开源。

在互联网架构中,数据系统通常被划分为数据源系统,作为基础数据库来存储用户生成的写操作;并派生数据库或索引以提供读取和其他复杂查询操作。后者往往来源于独立的数据存储,对其中的数据进行变换,有时还包括复杂的业务逻辑处理。缓存中的数据也来自主数据存储。当主数据存储发生变化时,缓存中的数据需要刷新或失效。

LinkedIn内部有很多专用的数据存储和服务系统,形成了一个多元化的生态系统。基本的 OLTP 数据存储用于处理面向用户的写操作和部分读操作。其他专用系统提供负责任的查询,或使用缓存来加速查询结果。因此,整个生态系统需要一个可靠的、支持事务的、一致的数据变更捕获系统。

Databus 是一种实时低延迟数据捕获系统。从2005年开始开发,2011年在LinkedIn上正式进入生产系统。

在 Databus 的 Github 页面上,他们介绍了他们选择当前解决方案的决策过程。

有两种常见的方法来处理这种需求:

应用驱动双向写:在这种模式下,应用层同时向数据库和另一个消息系统发起写操作。这个实现看起来很简单,因为写入数据库的应用程序代码是可以控制的。但是会引入一致性问题,因为没有复杂的协调协议(比如两阶段提交协议或者paxos算法),所以当出现问题时,很难保证数据库和消息系统完全锁定相同的状态。两个系统需要准确完成相同的写操作,并以相同的顺序完成序列化。如果写操作是有条件的或者有部分更新语义,那么事情会变得更加麻烦。

数据库日志挖掘:将数据库作为真实数据的唯一来源,从事务或提交日志中提取更改。这样可以解决一致性问题,但是很难实现,因为Oracle、MySQL等数据库有私有事务日志格式和复制冗余方案,版本升级后很难保证可用性。由于解决方案是处理由应用程序代码发起的数据更改,然后将它们写入另一个数据库,因此冗余系统必须是用户级的并且独立于源。对于瞬息万变的科技公司来说,这种与数据源的独立性对于避免应用程序堆栈的技术锁定或绑定到二进制格式非常重要。

在评估了两种方法的优缺点后,我们决定选择日志挖掘,以一致性和单一事实来源为最高优先级,而不是易于实施。

Databus 传输层的端到端延迟为微秒。每个服务器每秒可以处理数千个数据吞吐量更改事件。它还支持无限回溯能力和丰富的变更订阅功能。大纲结构如下图所示。

从图中可以看出,Search Index 和 Read Replicas 等系统是 Databus 的消费者。当主OLTP数据库发生写操作时,与其相连的中继系统会将数据拉取到中继。在搜索索引或缓存中签入的数据总线消费者客户端将从中继中提取数据并更新索引或缓存。

数据总线提供以下功能:

上图介绍了Databus系统的组成,包括中继、引导服务和客户端库。Bootstrap 服务包括 Bootstrap Producer 和 Bootstrap Server。快速变化的消费者直接从 Relay 获取事件。如果消费者的数据更新明显滞后,那么它需要的数据不在 Relay 日志中,而是在 Bootstrap Producer 中。提交给它的数据将是自消费者上次处理更改以来所有数据更改的快照。

数据总线继电器的功能主要包括:

从数据总线源读取更改的行并将它们序列化为内存缓存中的数据总线更改事件。侦听来自 Databus 客户端(包括 Bootstrap Producer)的请求并传输新的 Databus 数据更改事件。

Databus客户端的功能主要包括:

在Relay上查看新的数据变化事件,执行具体业务逻辑的回调。如果 Relay 太落后,则向 Bootstrap Server 发起查询。新的Databus客户端会向Bootstrap Server发起bootstrap启动查询,然后切换到relay发起查询。为了完成最新的数据变化事件,单个客户端可以处理整个Databus数据流,也可以成为消费者集群的一部分,每个消费者只处理部分流数据

Databus Bootstrap Producer只是一个特定的Databus客户端,它的功能是:

检查中继上的新数据更改事件 将更改存储在 MySQL 数据库 MySQL 数据库中以供 Bootstrap 和客户端使用

Databus Bootstrap Server 的主要功能是监听来自Databus 客户端的请求,并返回长期追溯的数据变化事件。

在LinkedIn上,Databus支持的系统有:

对Databus项目感兴趣的同学可以到Github查看更多信息和相关源码。

实时抓取网页数据(感觉比较好的我的博客readability_广州日报发过广告但是推荐,服务器的话我买了google)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2021-09-30 01:05

实时抓取网页数据,导出成表格数据形式,日后可以选用聚合工具进行数据处理。如果能分页读取,就更好了。

三步:

1、评论的url

2、rss转化成html,

3、抓取更多的rss如果觉得以上工作量太大,可以适当尝试nginx+blogbus的工作方式,php程序可以简单实现postgres。

可以尝试一下自建rss!请参考这个项目pubmed-reader/china-chemical-reviews。虽然跟收费的几十万的公司比起来,但是写出来的结果就比较纯净了。

现在老百姓用的rss类的工具倒还是挺多的,不过我了解的还是收费的网页转化成txt格式,然后post到evernote中。

感觉比较好的我的博客readability_广州日报发过广告但是推荐,服务器的话我买了google镜像服务器,全球最好的服务器之一当然跟别的博客服务比不上google的全球性流量preload我觉得很赞把rawrawdata还有readlines都可以write成可读的txt大小很不错,文章api很直接,readability提供这个服务而且我觉得技术上没什么难度就是运维有点麻烦要备份(nginx)太蛋疼了这个项目下来是全包价,不用考虑运维可惜postrecipe差评,现在还在学习中另外不太符合本人懒癌拖延症的习惯。

阿里云和服务器配合ferrarireader,搭建的一个博客服务器,名字叫ferrari博客,感兴趣可以试试, 查看全部

实时抓取网页数据(感觉比较好的我的博客readability_广州日报发过广告但是推荐,服务器的话我买了google)

实时抓取网页数据,导出成表格数据形式,日后可以选用聚合工具进行数据处理。如果能分页读取,就更好了。

三步:

1、评论的url

2、rss转化成html,

3、抓取更多的rss如果觉得以上工作量太大,可以适当尝试nginx+blogbus的工作方式,php程序可以简单实现postgres。

可以尝试一下自建rss!请参考这个项目pubmed-reader/china-chemical-reviews。虽然跟收费的几十万的公司比起来,但是写出来的结果就比较纯净了。

现在老百姓用的rss类的工具倒还是挺多的,不过我了解的还是收费的网页转化成txt格式,然后post到evernote中。

感觉比较好的我的博客readability_广州日报发过广告但是推荐,服务器的话我买了google镜像服务器,全球最好的服务器之一当然跟别的博客服务比不上google的全球性流量preload我觉得很赞把rawrawdata还有readlines都可以write成可读的txt大小很不错,文章api很直接,readability提供这个服务而且我觉得技术上没什么难度就是运维有点麻烦要备份(nginx)太蛋疼了这个项目下来是全包价,不用考虑运维可惜postrecipe差评,现在还在学习中另外不太符合本人懒癌拖延症的习惯。

阿里云和服务器配合ferrarireader,搭建的一个博客服务器,名字叫ferrari博客,感兴趣可以试试,

实时抓取网页数据(Python爬虫39-100天津市科技计划项目成果库(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-09-29 15:13

阿里云>云栖社区>主题图>W>网站 分页数据抓取

推荐活动:

更多优惠>

当前主题:网站 分页数据捕获并添加到采集夹

相关话题:

网站分页数据爬取相关博客查看更多博客

Python爬虫入门教程29-100手机APP数据抓取pyspider

作者:梦之橡皮 1318人浏览评论:02年前

1.手机APP资料----写在前面,继续练习pyspider的使用。最近搜了一下这个框架的一些使用技巧,发现文档比较难懂,但暂时没有障碍使用。我想,要写关于这个框架的 5 个教程。今天的教程增加了图片处理,大家可以重点学习。2.

阅读全文

Python爬虫入门教程39-100天津市科技项目成果库数据抓取Scrapy

作者:梦之橡皮 766人浏览评论:02年前

我今天不打算抢这个网站。无意中看到微信群里有人问这个网站。我想看看有什么特别复杂的。运行后发现这个网站很慢,经常自己崩溃,好像真的没什么特别的。。。爬网址

阅读全文

Python抓取欧洲足球联赛数据进行大数据分析

作者:青山无名 12610人浏览评论:14年前

背景网页抓取在大数据时代,一切都必须用数据说话。大数据处理过程一般需要以下几个步骤:数据采集和数据的采集、提取、变形、数据加载分析。, 探索和预测数据的显示。首先要做的是获取数据,提取出有效数据,用于下一步的分析。

阅读全文

使用 Scrapy 抓取数据

作者:雨客6542人浏览评论:05年前

Scrapy 是一个由 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站和从页面中提取结构化数据。Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。官方主页:中文文档:Scrap

阅读全文

Scrapy爬虫成长日记将爬取的内容写入mysql数据库

作者:呵呵 99251585人浏览评论:03年前

我尝试scrapy抓取博客园的博客(可以查看scrapy爬虫成长日记的创建项目-提取数据-以json格式保存数据),但是之前抓取的数据是以json格式保存为文本的文件。这显然不能满足我们日常的实际应用。接下来我们看看如何将抓取到的内容保存在一个普通的m中

阅读全文

Scrapy爬虫成长日记将爬取的内容写入mysql数据库

作者:无声胜有生 732人浏览评论:06年前

我尝试scrapy抓取博客园的博客(可以在这里查看scrapy爬虫成长日记的创建项目-提取数据-以json格式保存数据),但是之前抓取的数据是以json格式保存为文本的文件。这显然不符合我们日常的实际应用。接下来我们来看看常见的抓取内容的保存方式

阅读全文

“全民K歌”的秘诀是什么?网站数据采集用于数据分析

作者:逆一睡2103人浏览评论:03年前

最近看到身边好几个朋友在手机上用“全民K歌”软件唱歌。使用频率还是很高的,所以想看看全民K歌平台的用户是怎样的用户?有什么特点。然后进行数据分析,加强你的分析思维和实践能力。这个过程我会分四个部分来写:数据采集、数据清洗、数据

阅读全文

使用MVCPager对博客园首页列表数据进行分页展示功能

作者:建筑师郭果940人浏览评论:08年前

在上一篇博文中,我使用正则表达式抓取了博客园的列表数据。我用正则表达式抓取了博客园的部分数据作为测试数据。现在测试数据也可用了,应该分页显示数据。但是如何分页让我犹豫了几分钟。我应该编写javascript来自定义分页显示,还是使用现成的控件来执行拆分。

阅读全文 查看全部

实时抓取网页数据(Python爬虫39-100天津市科技计划项目成果库(组图))

阿里云>云栖社区>主题图>W>网站 分页数据抓取

推荐活动:

更多优惠>

当前主题:网站 分页数据捕获并添加到采集夹

相关话题:

网站分页数据爬取相关博客查看更多博客

Python爬虫入门教程29-100手机APP数据抓取pyspider

作者:梦之橡皮 1318人浏览评论:02年前

1.手机APP资料----写在前面,继续练习pyspider的使用。最近搜了一下这个框架的一些使用技巧,发现文档比较难懂,但暂时没有障碍使用。我想,要写关于这个框架的 5 个教程。今天的教程增加了图片处理,大家可以重点学习。2.

阅读全文

Python爬虫入门教程39-100天津市科技项目成果库数据抓取Scrapy

作者:梦之橡皮 766人浏览评论:02年前

我今天不打算抢这个网站。无意中看到微信群里有人问这个网站。我想看看有什么特别复杂的。运行后发现这个网站很慢,经常自己崩溃,好像真的没什么特别的。。。爬网址

阅读全文

Python抓取欧洲足球联赛数据进行大数据分析

作者:青山无名 12610人浏览评论:14年前

背景网页抓取在大数据时代,一切都必须用数据说话。大数据处理过程一般需要以下几个步骤:数据采集和数据的采集、提取、变形、数据加载分析。, 探索和预测数据的显示。首先要做的是获取数据,提取出有效数据,用于下一步的分析。

阅读全文

使用 Scrapy 抓取数据

作者:雨客6542人浏览评论:05年前

Scrapy 是一个由 Python 开发的快速、高级的屏幕抓取和网页抓取框架,用于抓取网站和从页面中提取结构化数据。Scrapy 用途广泛,可用于数据挖掘、监控和自动化测试。官方主页:中文文档:Scrap

阅读全文

Scrapy爬虫成长日记将爬取的内容写入mysql数据库

作者:呵呵 99251585人浏览评论:03年前

我尝试scrapy抓取博客园的博客(可以查看scrapy爬虫成长日记的创建项目-提取数据-以json格式保存数据),但是之前抓取的数据是以json格式保存为文本的文件。这显然不能满足我们日常的实际应用。接下来我们看看如何将抓取到的内容保存在一个普通的m中

阅读全文

Scrapy爬虫成长日记将爬取的内容写入mysql数据库

作者:无声胜有生 732人浏览评论:06年前

我尝试scrapy抓取博客园的博客(可以在这里查看scrapy爬虫成长日记的创建项目-提取数据-以json格式保存数据),但是之前抓取的数据是以json格式保存为文本的文件。这显然不符合我们日常的实际应用。接下来我们来看看常见的抓取内容的保存方式

阅读全文

“全民K歌”的秘诀是什么?网站数据采集用于数据分析

作者:逆一睡2103人浏览评论:03年前

最近看到身边好几个朋友在手机上用“全民K歌”软件唱歌。使用频率还是很高的,所以想看看全民K歌平台的用户是怎样的用户?有什么特点。然后进行数据分析,加强你的分析思维和实践能力。这个过程我会分四个部分来写:数据采集、数据清洗、数据

阅读全文

使用MVCPager对博客园首页列表数据进行分页展示功能

作者:建筑师郭果940人浏览评论:08年前

在上一篇博文中,我使用正则表达式抓取了博客园的列表数据。我用正则表达式抓取了博客园的部分数据作为测试数据。现在测试数据也可用了,应该分页显示数据。但是如何分页让我犹豫了几分钟。我应该编写javascript来自定义分页显示,还是使用现成的控件来执行拆分。

阅读全文

实时抓取网页数据( 手机网站怎样获取网站手机号的数据好的方法?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2021-09-29 15:10

手机网站怎样获取网站手机号的数据好的方法?)

获取网站手机号码数据,同行号码抢标签

获取网站手机号码数据,同行号码抢标签

你要获取网站的手机号码数据。如果你想走捷径,寻找新的资源,有什么办法吗?同时,我也想抢我同行的手机号。有什么好处吗?方法?

很多时候,我们会猜测一家公司可能有需求,但我们找不到联系方式。这时候就要善于使用各种工具,比如上面提到的企业搜索、天眼查、Atub等企业信息网。关联公司间接寻找交易对手。

此外,您还可以通过百度、企业网站、招聘网信息等找到公司的同行号并抓取,或者通过LinkedIn、麦麦等社交工具寻找公司内部人员。

找到联系人后,通常会有一个问题,就是如何找到关键人?可能会被前台和助理拦截,不可能把产品介绍给有决策权的人。

从手机网站获取访问者手机号的方式有多种。一种是更改手机号码数据,获取网站手机号码数据,看看能不能找到能讲讲的人。一种是直接上门,陌生人来访。一是处理前台和助理。这需要一些技巧,比如让对方意识到这件事的重要性,或者对他有好处,或者通过做某种礼貌,让他愿意帮助你。

不过上面的方法确实有点过时了,数据也不准确。获取网站手机号码数据和同行抢号标签,您可以完全联系我们,我们免费指导您。 查看全部

实时抓取网页数据(

手机网站怎样获取网站手机号的数据好的方法?)

获取网站手机号码数据,同行号码抢标签

获取网站手机号码数据,同行号码抢标签

你要获取网站的手机号码数据。如果你想走捷径,寻找新的资源,有什么办法吗?同时,我也想抢我同行的手机号。有什么好处吗?方法?

很多时候,我们会猜测一家公司可能有需求,但我们找不到联系方式。这时候就要善于使用各种工具,比如上面提到的企业搜索、天眼查、Atub等企业信息网。关联公司间接寻找交易对手。

此外,您还可以通过百度、企业网站、招聘网信息等找到公司的同行号并抓取,或者通过LinkedIn、麦麦等社交工具寻找公司内部人员。

找到联系人后,通常会有一个问题,就是如何找到关键人?可能会被前台和助理拦截,不可能把产品介绍给有决策权的人。

从手机网站获取访问者手机号的方式有多种。一种是更改手机号码数据,获取网站手机号码数据,看看能不能找到能讲讲的人。一种是直接上门,陌生人来访。一是处理前台和助理。这需要一些技巧,比如让对方意识到这件事的重要性,或者对他有好处,或者通过做某种礼貌,让他愿意帮助你。

不过上面的方法确实有点过时了,数据也不准确。获取网站手机号码数据和同行抢号标签,您可以完全联系我们,我们免费指导您。

实时抓取网页数据(如何通过沉迷于抓取实时数据将您的业务提升到一个新水平)

网站优化 • 优采云 发表了文章 • 0 个评论 • 116 次浏览 • 2021-09-29 02:10

现代世界都是关于技术以及我们如何充分利用它;实时捕获数据只是这个技术驱动世界的革命性方面之一。我们将向您展示如何通过捕获实时数据将您的业务提升到一个新的水平。在线可用的数据量巨大且不断变化;因此,如果您想在这个竞争激烈的世界中保持相关性,跟上这些变化至关重要。信息不足或不正确不应成为您失败的原因,我们会告诉您如何捕获实时数据并提高准确性。

许多新的或小型企业主询问什么是实时数据抓取以及它如何使他们受益。让我们回答这些基本常见问题以消除混淆。

网页抓取是一个自动化过程,它倾向于从 网站 采集信息并将其传输到各种电子表格和数据库。它是处理网络信息最快的数据提取方法,最适用于不断变化的数据,例如股票价格、冠状病毒病例、天气预报等。实时网络爬虫可以很容易地跟上这些变化和在现代世界中获得了极大的欢迎。一个悬而未决的问题是如何捕获实时数据?有什么要求以及如何去做?

现在,让我来回答这个问题。程序员和非程序员都可以轻松提取实时数据。程序员可以通过编写自己的爬虫/爬虫来抓取实时数据,了解具体的内容需求、语言等。这里的另一个问题是,你刚开发的爬虫可能一周内无法工作,所以需要不断修复错误,这可能很昂贵。让我们变得真实;为新的或小型企业招聘程序员并不完全可行,因为它很昂贵。那么,这些小企业如何应对这个庞大且不断变化的数据池呢?最好的方法是使用现有的和预制的实时数据捕获工具和软件。预制网络爬虫允许您提取相关数据并下载特定网页。这可以包括可用产品及其价格的列表,可用性和其他重要信息。它们的自动化功能通常给它们带来巨大的优势,因为它们可以轻松检测 Web 结构、获取数据、解析 HTML 并将所有这些都集成到您的数据库中。随着时间的推移,它们变得非常受欢迎,为什么不呢,因为它们便于携带,而且往往可以节省大量时间。

我们现在已经确定了网络抓取的重要性以及使用数据提取工具的好处。接下来,我们需要决定必须使用哪种数据提取工具,因为这些工具和软件正在充斥市场。为您选择合适的唯一方法是了解您的需求。使用web扩展可以提取实时数据,它是浏览器的一个小插件,但功能有限,安全性不确定。数据提取软件是您的另一个选择。它必须安装在系统中,并且由于其现代和先进的功能,它非常适合处理敏感数据。

数据抓取软件有很多,比如ScrapingBee、ScrapingBot、Scraper AP I等,但是我给大家介绍一下我们最喜欢的网页抓取软件——Octoparse。

我相信所有其他软件都很好,但 Octoparse 有一些特殊的品质,使其比其他软件更具优势。这对于从多个网络源进行大规模实时数据捕获非常有用。我们可以保证每个小企业都会从其独特的功能中受益,因为它不是您普通的刮板。它以其广泛的工具超越了大多数工具。

预设提取模块不受任何复杂配置的约束,倾向于立即读取结果。它涵盖了所有重要的网站,无论是社交媒体、电子商务等。它适合所有人,因为它具有三种不同的模式,迎合初学者、季节专业人士和自定义爬虫,可以快速、即时地获取数据以及他们需要的信息。它拥有丰富的、无所不包的功能,如RegEx编辑、任务调度、JSON抓取等,将你的实时抓取提升到一个新的水平。

使用 Octoparse,您甚至可以从 Ad-heavy 页面中提取数据,因为其出色的 Ad-block 功能可以解决这个问题。它倾向于模仿人类,同时从各种 网站 抓取数据,并允许我们在您的系统或云上运行提取的信息。Octoparse 的另一个前沿特性是它可以导出各种捕获的数据,包括 CSV、TXT、HTML,甚至 Excel 格式。Octoparse 中的所有模板都非常人性化,因此不需要专业程序员;只需点击几下鼠标即可轻松获取数据,而无需花费一分钱。

归根结底,这是您决定考虑什么最有利于您的业务及其增长和繁荣。因此,您可以探索所有可用的不同软件来帮助您实时抓取数据,但在结束本文之前,让我们给您一个建议。去下载 Octoparse,探索它的功能,了解为什么我们认为它是最好的网络抓取软件,然后自己决定。它是免费的并可在线获得,所以准备好被震撼吧! 查看全部

实时抓取网页数据(如何通过沉迷于抓取实时数据将您的业务提升到一个新水平)

现代世界都是关于技术以及我们如何充分利用它;实时捕获数据只是这个技术驱动世界的革命性方面之一。我们将向您展示如何通过捕获实时数据将您的业务提升到一个新的水平。在线可用的数据量巨大且不断变化;因此,如果您想在这个竞争激烈的世界中保持相关性,跟上这些变化至关重要。信息不足或不正确不应成为您失败的原因,我们会告诉您如何捕获实时数据并提高准确性。

许多新的或小型企业主询问什么是实时数据抓取以及它如何使他们受益。让我们回答这些基本常见问题以消除混淆。

网页抓取是一个自动化过程,它倾向于从 网站 采集信息并将其传输到各种电子表格和数据库。它是处理网络信息最快的数据提取方法,最适用于不断变化的数据,例如股票价格、冠状病毒病例、天气预报等。实时网络爬虫可以很容易地跟上这些变化和在现代世界中获得了极大的欢迎。一个悬而未决的问题是如何捕获实时数据?有什么要求以及如何去做?

现在,让我来回答这个问题。程序员和非程序员都可以轻松提取实时数据。程序员可以通过编写自己的爬虫/爬虫来抓取实时数据,了解具体的内容需求、语言等。这里的另一个问题是,你刚开发的爬虫可能一周内无法工作,所以需要不断修复错误,这可能很昂贵。让我们变得真实;为新的或小型企业招聘程序员并不完全可行,因为它很昂贵。那么,这些小企业如何应对这个庞大且不断变化的数据池呢?最好的方法是使用现有的和预制的实时数据捕获工具和软件。预制网络爬虫允许您提取相关数据并下载特定网页。这可以包括可用产品及其价格的列表,可用性和其他重要信息。它们的自动化功能通常给它们带来巨大的优势,因为它们可以轻松检测 Web 结构、获取数据、解析 HTML 并将所有这些都集成到您的数据库中。随着时间的推移,它们变得非常受欢迎,为什么不呢,因为它们便于携带,而且往往可以节省大量时间。

我们现在已经确定了网络抓取的重要性以及使用数据提取工具的好处。接下来,我们需要决定必须使用哪种数据提取工具,因为这些工具和软件正在充斥市场。为您选择合适的唯一方法是了解您的需求。使用web扩展可以提取实时数据,它是浏览器的一个小插件,但功能有限,安全性不确定。数据提取软件是您的另一个选择。它必须安装在系统中,并且由于其现代和先进的功能,它非常适合处理敏感数据。

数据抓取软件有很多,比如ScrapingBee、ScrapingBot、Scraper AP I等,但是我给大家介绍一下我们最喜欢的网页抓取软件——Octoparse。

我相信所有其他软件都很好,但 Octoparse 有一些特殊的品质,使其比其他软件更具优势。这对于从多个网络源进行大规模实时数据捕获非常有用。我们可以保证每个小企业都会从其独特的功能中受益,因为它不是您普通的刮板。它以其广泛的工具超越了大多数工具。

预设提取模块不受任何复杂配置的约束,倾向于立即读取结果。它涵盖了所有重要的网站,无论是社交媒体、电子商务等。它适合所有人,因为它具有三种不同的模式,迎合初学者、季节专业人士和自定义爬虫,可以快速、即时地获取数据以及他们需要的信息。它拥有丰富的、无所不包的功能,如RegEx编辑、任务调度、JSON抓取等,将你的实时抓取提升到一个新的水平。

使用 Octoparse,您甚至可以从 Ad-heavy 页面中提取数据,因为其出色的 Ad-block 功能可以解决这个问题。它倾向于模仿人类,同时从各种 网站 抓取数据,并允许我们在您的系统或云上运行提取的信息。Octoparse 的另一个前沿特性是它可以导出各种捕获的数据,包括 CSV、TXT、HTML,甚至 Excel 格式。Octoparse 中的所有模板都非常人性化,因此不需要专业程序员;只需点击几下鼠标即可轻松获取数据,而无需花费一分钱。

归根结底,这是您决定考虑什么最有利于您的业务及其增长和繁荣。因此,您可以探索所有可用的不同软件来帮助您实时抓取数据,但在结束本文之前,让我们给您一个建议。去下载 Octoparse,探索它的功能,了解为什么我们认为它是最好的网络抓取软件,然后自己决定。它是免费的并可在线获得,所以准备好被震撼吧!

实时抓取网页数据(如何使搜索引擎能够在网站上爬行很长时间?的SEO优化方法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-09-28 04:04

如何让搜索引擎长时间抓取网站?今天,优帮云小编将分享几种网站 SEO优化方法,增加搜索引擎蜘蛛的抓取:

1、 简洁代码:站点代码是搜索引擎爬取的第一步。不要显示很多搜索引擎不理解或无法识别的代码。就像我们走路一样,当道路崎岖不平时,我们不想走两次就一次。因此,代码的简洁有利于搜索引擎的抓取,也方便搜索引擎在网站上长期停留。

2、合理的内链:网站的内链决定了网站收录的内容量,内链也是提升内容用户体验的要素之一。对于搜索引擎来说,合理的内链可以有效减少索引爬取的时间。换句话说,当我们工作时,我们会找到一种非常快速的方法来节省大量时间并按时完成工作。这个时候,我们会选择一种快捷的方式来做。所以网站内的链接还是很重要的。

3、网站 更新频率:在很多情况下,很多站长的网站并不是每天都收录在同一个数字中,因为他们没有定期更新。当搜索引擎第一次输入你的网站时,如果有更新,自然会被收录输入。第二次,没有更新。第三次,没有更新。第四次,没有更新。第五次,没有更新。这种不规律的更新频率很容易让搜索引擎对这个网站失去兴趣,所以搜索引擎自然不会停留在这个网站上。

如何让蜘蛛频繁抓取网站的内容?

4、文字导航:众所周知,没有ALT标签,搜索引擎无法识别图片和flash。所以让搜索引擎对你的网站有足够的兴趣。您需要优化您的图片。而清晰的导航也对用户体验起到了一定的作用。

5、内容质量:所有网站管理员都知道搜索引擎喜欢原创内容,但原创内容是高质量的吗?这不一定。原创文章 添加对用户有价值的内容。这就是搜索引擎喜欢的。我们如何区分?首先,搜索引擎是一个程序,自然判断取决于网站的PV值。这样,搜索引擎就会分析内容的质量。

6、网站 外链质量:从表面上看,网站的外链对搜索引擎的爬行没有影响,但如果你深入了解,你会发现它是不同的。因为当外链质量高时,自然就意味着发布外链的地方权重高,所以这些地方的搜索引擎自然会更加忠诚。因此,外链的质量也有一定的影响。

7、 结构要合理:很多朋友往往只关注网站的外部优化。很多人认为发布链的使命是可以实现的。但是很少有人关注网站内部结构的优化,即内部优化。网站 目录不要超过3层,也就是点击3次就可以到达网站的任何页面,这是一个很好的结构。 查看全部

实时抓取网页数据(如何使搜索引擎能够在网站上爬行很长时间?的SEO优化方法)

如何让搜索引擎长时间抓取网站?今天,优帮云小编将分享几种网站 SEO优化方法,增加搜索引擎蜘蛛的抓取:

1、 简洁代码:站点代码是搜索引擎爬取的第一步。不要显示很多搜索引擎不理解或无法识别的代码。就像我们走路一样,当道路崎岖不平时,我们不想走两次就一次。因此,代码的简洁有利于搜索引擎的抓取,也方便搜索引擎在网站上长期停留。

2、合理的内链:网站的内链决定了网站收录的内容量,内链也是提升内容用户体验的要素之一。对于搜索引擎来说,合理的内链可以有效减少索引爬取的时间。换句话说,当我们工作时,我们会找到一种非常快速的方法来节省大量时间并按时完成工作。这个时候,我们会选择一种快捷的方式来做。所以网站内的链接还是很重要的。

3、网站 更新频率:在很多情况下,很多站长的网站并不是每天都收录在同一个数字中,因为他们没有定期更新。当搜索引擎第一次输入你的网站时,如果有更新,自然会被收录输入。第二次,没有更新。第三次,没有更新。第四次,没有更新。第五次,没有更新。这种不规律的更新频率很容易让搜索引擎对这个网站失去兴趣,所以搜索引擎自然不会停留在这个网站上。

如何让蜘蛛频繁抓取网站的内容?

4、文字导航:众所周知,没有ALT标签,搜索引擎无法识别图片和flash。所以让搜索引擎对你的网站有足够的兴趣。您需要优化您的图片。而清晰的导航也对用户体验起到了一定的作用。

5、内容质量:所有网站管理员都知道搜索引擎喜欢原创内容,但原创内容是高质量的吗?这不一定。原创文章 添加对用户有价值的内容。这就是搜索引擎喜欢的。我们如何区分?首先,搜索引擎是一个程序,自然判断取决于网站的PV值。这样,搜索引擎就会分析内容的质量。

6、网站 外链质量:从表面上看,网站的外链对搜索引擎的爬行没有影响,但如果你深入了解,你会发现它是不同的。因为当外链质量高时,自然就意味着发布外链的地方权重高,所以这些地方的搜索引擎自然会更加忠诚。因此,外链的质量也有一定的影响。

7、 结构要合理:很多朋友往往只关注网站的外部优化。很多人认为发布链的使命是可以实现的。但是很少有人关注网站内部结构的优化,即内部优化。网站 目录不要超过3层,也就是点击3次就可以到达网站的任何页面,这是一个很好的结构。

实时抓取网页数据(与网络机器人的污名污名,我们能做些什么呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 97 次浏览 • 2021-09-28 04:00

“网上有很多资料”,这样说也太保守了。事实上,到 2020 年,“数字宇宙”预计将拥有 40 万亿字节或 40 泽字节的信息,而 1 泽字节的数据足以填满一个约曼哈顿五分之一大小的数据中心。

有了这么多可用于分析的信息,将采集数据的任务留给 AI 是有意义的。网络机器人可以以惊人的速度抓取网页并提取他们需要的相关信息。然而,尽管许多数据科学家和营销人员以完全合乎道德的方式获取和使用这些信息。遗憾的是,随着网络人工智能的日益普及,网络机器人正逐渐被污名化。

人工智能的大部分负面印象都是由好莱坞电影和科幻小说间接造成的。毕竟,在这些作品中,即使 AI 是最美丽、最令人愉快的,也要提防它。此外,一些网络用户以不道德的方式使用网络机器人,甚至导致那些专业和真诚地使用数据的人受到打击。

对于许多专业人士来说,网页抓取仍然是必不可少的工具。那么,对于与网络机器人相关的污名,我们能做些什么呢?

首先,什么是网页抓取

您可以简单地将网络抓取行为理解为数据提取。尽管数据科学家和其他专业人士使用抓取来分析非常复杂的数字信息堆栈,但从 网站 复制和粘贴文本的行为本身可以被视为一种简单的抓取形式。

但是,即使您可以在 网站 上随意访问,但由于可用信息量大,从来源采集数据可能需要很长时间。大多数情况下,网络爬虫留给了人工智能,它会彻底分析检索到的数据以达到各种目的。虽然这对网络爬虫来说极为方便,但网站 站长和旁观者非常担心人工智能在互联网上的“滥用”

使用网络机器人进行网络抓取会更好吗

有这么多信息要分析,很自然地转向人工智能来采集数据。事实上,对于感兴趣的各方来说,谷歌本身就是最可靠的网络抓取工具来源之一。例如,您可以使用其数据集搜索引擎快速访问您认为可以免费使用的数据,甚至可以自定义搜索以查看信息是否可以用于商业目的。完成这些任务只需要几秒钟。

如果没有谷歌AI如此高效地检查每个网站的相关数据,恐怕达不到这个速度。这是使用人工智能以纯粹的道德方式为研究或商业采集有用信息的完美例子。它的速度也证明了“网络机器人”如何让执行网络抓取任务变得如此容易。

人工智能流量已经变得如此普遍,以至于它现在占互联网流量的一半以上。即便如此,我们也很容易忽视它的影响。

有人认为人工智能在互联网流量中的主导地位令人担忧。让这个问题变得更糟的是,一小部分 AI 流量是由“坏机器人”组成的。即使抓捕的意图是好的,方法是合乎道德的,人工智能的污名仍然不可避免。

使用网络机器人处理大量数据是一个合理的步骤。除了人工智能,在抓取网络数据时考虑其他必要的工具也很重要。

代理如何提供帮助

使用代理进行网络抓取有很多优点,匿名就是其中之一。例如,如果您想对竞争品牌进行研究并使用此信息来确定改善公司发展的最佳方式,您可能不希望其他人知道您访问了他们的 网站。在这种情况下,使用代理可以在不泄露身份的情况下访问和检查数据,这是两全其美的。

在继续之前,让我们快速回顾一下代理服务器:

代理服务器旨在充当用户和 Web 服务器之间的中介。

多功能:个人和公司都可以使用代理服务器来满足特定需求。

代理的一个常见用途与网络抓取有关:使用代理服务器可以绕过网站 管理员设置的限制并采集大量数据。

那么问题来了,为什么要限制呢?这些数据不是可以在线免费获得吗?对于人类用户,是的。这是一个典型的例子。价格聚合器的整个商业模式都基于准确的信息。它为“我在哪里可以买到价格最低的 X 产品?”这个问题提供了准确的答案。

尽管这是客户省钱的好机会,但供应商对其他公司窥探他们的数据并不太感兴趣。原因是聚合器的网络爬虫软件(通常称为“网络机器人”或“网络蜘蛛”)“)给网站带来额外的负载。因此,如果网站管理员怀疑给定的网络活动不是由真实用户执行的,用户将被限制访问网站。

代理的另一个实际用途是逃避审查禁令。住宅代理,顾名思义,将显示您是来自 X 国的真实用户,您可以自定义您来自哪个国家。对住宅代理的需求很简单:(可疑的)网络机器人活动通常来自某些国家/地区,因此即使是来自这些国家/地区的真实用户也经常遇到地域限制。

此外,当您尝试从数据源采集数据但由于各种原因无法访问它时,使用代理特别有用。在网络抓取中使用代理的方法有很多,但为了在数字社区中建立信任,我们建议您坚持使用那些可以建立品牌信任和权威的方法。

使用人类知名度和值得信赖的品牌来对抗人工智能的污名

目前,人工智能的发展速度确实已经超过了网民的增长速度。但是,未来几年互联网将如何发展仍是未知数,因此没有理由立即断定这种趋势不可逆转,也不能断定它代表了一种固有的负面趋势。

如果要扭转互联网上关于人工智能流量的负面评论,最好的办法就是让人工智能在互联网上的使用回归人性。还应该指出的是,无需过多考虑以建立信任的方式使用人工智能。

坚持使用认可度高、值得信赖的品牌提供的可靠产品和服务。

坚持道德的网络爬行操作。不要滥用信任,忽略网站上的robots.txt文件,或者短时间内大量使用机器人程序。

以专业和负责任的方式使用数据。验证您是否有权将抓取的数据用于预期目的。

大量普及人工智能。与其他人讨论如何以及为什么使用网页抓取,让人们对网页抓取有更深入的了解。人们越了解使用人工智能获取和研究大量数据的好处,他们就越不可能对网络抓取和网络机器人产生负面看法。

通过纯手动操作来手动访问网站数据可能让人放心,但由于信息太多,几乎不可能。可用数据的数量几乎是无穷无尽的。使用人工智能是我们尽可能高效地浏览网站和分析数据的最佳方式。然而,它可能需要多加一点“人情味”。 查看全部

实时抓取网页数据(与网络机器人的污名污名,我们能做些什么呢?)

“网上有很多资料”,这样说也太保守了。事实上,到 2020 年,“数字宇宙”预计将拥有 40 万亿字节或 40 泽字节的信息,而 1 泽字节的数据足以填满一个约曼哈顿五分之一大小的数据中心。

有了这么多可用于分析的信息,将采集数据的任务留给 AI 是有意义的。网络机器人可以以惊人的速度抓取网页并提取他们需要的相关信息。然而,尽管许多数据科学家和营销人员以完全合乎道德的方式获取和使用这些信息。遗憾的是,随着网络人工智能的日益普及,网络机器人正逐渐被污名化。

人工智能的大部分负面印象都是由好莱坞电影和科幻小说间接造成的。毕竟,在这些作品中,即使 AI 是最美丽、最令人愉快的,也要提防它。此外,一些网络用户以不道德的方式使用网络机器人,甚至导致那些专业和真诚地使用数据的人受到打击。

对于许多专业人士来说,网页抓取仍然是必不可少的工具。那么,对于与网络机器人相关的污名,我们能做些什么呢?

首先,什么是网页抓取

您可以简单地将网络抓取行为理解为数据提取。尽管数据科学家和其他专业人士使用抓取来分析非常复杂的数字信息堆栈,但从 网站 复制和粘贴文本的行为本身可以被视为一种简单的抓取形式。

但是,即使您可以在 网站 上随意访问,但由于可用信息量大,从来源采集数据可能需要很长时间。大多数情况下,网络爬虫留给了人工智能,它会彻底分析检索到的数据以达到各种目的。虽然这对网络爬虫来说极为方便,但网站 站长和旁观者非常担心人工智能在互联网上的“滥用”

使用网络机器人进行网络抓取会更好吗

有这么多信息要分析,很自然地转向人工智能来采集数据。事实上,对于感兴趣的各方来说,谷歌本身就是最可靠的网络抓取工具来源之一。例如,您可以使用其数据集搜索引擎快速访问您认为可以免费使用的数据,甚至可以自定义搜索以查看信息是否可以用于商业目的。完成这些任务只需要几秒钟。

如果没有谷歌AI如此高效地检查每个网站的相关数据,恐怕达不到这个速度。这是使用人工智能以纯粹的道德方式为研究或商业采集有用信息的完美例子。它的速度也证明了“网络机器人”如何让执行网络抓取任务变得如此容易。

人工智能流量已经变得如此普遍,以至于它现在占互联网流量的一半以上。即便如此,我们也很容易忽视它的影响。

有人认为人工智能在互联网流量中的主导地位令人担忧。让这个问题变得更糟的是,一小部分 AI 流量是由“坏机器人”组成的。即使抓捕的意图是好的,方法是合乎道德的,人工智能的污名仍然不可避免。

使用网络机器人处理大量数据是一个合理的步骤。除了人工智能,在抓取网络数据时考虑其他必要的工具也很重要。

代理如何提供帮助

使用代理进行网络抓取有很多优点,匿名就是其中之一。例如,如果您想对竞争品牌进行研究并使用此信息来确定改善公司发展的最佳方式,您可能不希望其他人知道您访问了他们的 网站。在这种情况下,使用代理可以在不泄露身份的情况下访问和检查数据,这是两全其美的。

在继续之前,让我们快速回顾一下代理服务器:

代理服务器旨在充当用户和 Web 服务器之间的中介。

多功能:个人和公司都可以使用代理服务器来满足特定需求。

代理的一个常见用途与网络抓取有关:使用代理服务器可以绕过网站 管理员设置的限制并采集大量数据。

那么问题来了,为什么要限制呢?这些数据不是可以在线免费获得吗?对于人类用户,是的。这是一个典型的例子。价格聚合器的整个商业模式都基于准确的信息。它为“我在哪里可以买到价格最低的 X 产品?”这个问题提供了准确的答案。

尽管这是客户省钱的好机会,但供应商对其他公司窥探他们的数据并不太感兴趣。原因是聚合器的网络爬虫软件(通常称为“网络机器人”或“网络蜘蛛”)“)给网站带来额外的负载。因此,如果网站管理员怀疑给定的网络活动不是由真实用户执行的,用户将被限制访问网站。

代理的另一个实际用途是逃避审查禁令。住宅代理,顾名思义,将显示您是来自 X 国的真实用户,您可以自定义您来自哪个国家。对住宅代理的需求很简单:(可疑的)网络机器人活动通常来自某些国家/地区,因此即使是来自这些国家/地区的真实用户也经常遇到地域限制。

此外,当您尝试从数据源采集数据但由于各种原因无法访问它时,使用代理特别有用。在网络抓取中使用代理的方法有很多,但为了在数字社区中建立信任,我们建议您坚持使用那些可以建立品牌信任和权威的方法。

使用人类知名度和值得信赖的品牌来对抗人工智能的污名

目前,人工智能的发展速度确实已经超过了网民的增长速度。但是,未来几年互联网将如何发展仍是未知数,因此没有理由立即断定这种趋势不可逆转,也不能断定它代表了一种固有的负面趋势。

如果要扭转互联网上关于人工智能流量的负面评论,最好的办法就是让人工智能在互联网上的使用回归人性。还应该指出的是,无需过多考虑以建立信任的方式使用人工智能。

坚持使用认可度高、值得信赖的品牌提供的可靠产品和服务。

坚持道德的网络爬行操作。不要滥用信任,忽略网站上的robots.txt文件,或者短时间内大量使用机器人程序。

以专业和负责任的方式使用数据。验证您是否有权将抓取的数据用于预期目的。

大量普及人工智能。与其他人讨论如何以及为什么使用网页抓取,让人们对网页抓取有更深入的了解。人们越了解使用人工智能获取和研究大量数据的好处,他们就越不可能对网络抓取和网络机器人产生负面看法。

通过纯手动操作来手动访问网站数据可能让人放心,但由于信息太多,几乎不可能。可用数据的数量几乎是无穷无尽的。使用人工智能是我们尽可能高效地浏览网站和分析数据的最佳方式。然而,它可能需要多加一点“人情味”。

实时抓取网页数据(api服务器的状态有很多方法,你知道吗?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 81 次浏览 • 2021-09-27 04:04

实时抓取网页数据...多种方式...用不同的方式抓取就相当于发送不同的指令给不同的手机...对于少数性能低下的手机来说,经常会因为可用的带宽出现瓶颈,从而导致丢包。

与其说是抓,不如说是获取,然后与服务器来做交互。技术上很简单,请求时段就可以判断,api服务器本身也有判断这个时段资源是否有完整使用的能力。最后,一般公开的服务都会有api文档,不明白可以自己参考。

抓包是把你发给服务器的请求暴露给服务器,服务器拿到之后可以根据请求来判断这个请求的状态。

ajax本质是不是在请求中包含交互过程,或者http返回的数据。通过分析数据流,发现timeout的合理设置,通过简单的时域频域编程,发现xmlhttprequest可以用来传递数据,通过解析timeout内容,是可以抓到,然后转发给后台处理然后返回给服务器。

对于一般的页面来说一般在4-8s内最短的一个时间就是浏览器的resolved时间,就可以得知xmlhttprequest的状态在爬虫时通常xmlhttprequest的生命期是3天。用javascript获取请求头xmlhttprequest中xmlhttprequest-xmlhttprequest/response响应头accept、content-type、host、method等等。

接下来一般来说根据设定的timeout,就能计算出请求返回。但是对于特殊的页面不是一味的看时间的。一般判断xmlhttprequest的状态有很多方法1.基于timeouts一般是8-180s2.用浏览器的话可以用location,在xmlhttprequest内利用vue-response来封装可以利用xmlhttprequest3.用http请求服务器返回的响应头来判断从内容大小来看,通常为content-typemultipart/form-datatext/html5xml/css5其中content-type为multipart/form-datatext/html54.可以请求https除了xmlhttprequest和httpresponse结合那些其他的就需要使用protocolresponse等等。 查看全部

实时抓取网页数据(api服务器的状态有很多方法,你知道吗?)

实时抓取网页数据...多种方式...用不同的方式抓取就相当于发送不同的指令给不同的手机...对于少数性能低下的手机来说,经常会因为可用的带宽出现瓶颈,从而导致丢包。

与其说是抓,不如说是获取,然后与服务器来做交互。技术上很简单,请求时段就可以判断,api服务器本身也有判断这个时段资源是否有完整使用的能力。最后,一般公开的服务都会有api文档,不明白可以自己参考。

抓包是把你发给服务器的请求暴露给服务器,服务器拿到之后可以根据请求来判断这个请求的状态。

ajax本质是不是在请求中包含交互过程,或者http返回的数据。通过分析数据流,发现timeout的合理设置,通过简单的时域频域编程,发现xmlhttprequest可以用来传递数据,通过解析timeout内容,是可以抓到,然后转发给后台处理然后返回给服务器。

对于一般的页面来说一般在4-8s内最短的一个时间就是浏览器的resolved时间,就可以得知xmlhttprequest的状态在爬虫时通常xmlhttprequest的生命期是3天。用javascript获取请求头xmlhttprequest中xmlhttprequest-xmlhttprequest/response响应头accept、content-type、host、method等等。

接下来一般来说根据设定的timeout,就能计算出请求返回。但是对于特殊的页面不是一味的看时间的。一般判断xmlhttprequest的状态有很多方法1.基于timeouts一般是8-180s2.用浏览器的话可以用location,在xmlhttprequest内利用vue-response来封装可以利用xmlhttprequest3.用http请求服务器返回的响应头来判断从内容大小来看,通常为content-typemultipart/form-datatext/html5xml/css5其中content-type为multipart/form-datatext/html54.可以请求https除了xmlhttprequest和httpresponse结合那些其他的就需要使用protocolresponse等等。

实时抓取网页数据(用websocket技术,在运维工具的浏览器上实时显示远程服务器上的日志信息)

网站优化 • 优采云 发表了文章 • 0 个评论 • 224 次浏览 • 2021-09-26 14:15

功能:使用websocket技术,在运维工具的浏览器上实时显示远程服务器上的日志信息

一般我们在部署运维工具的环境时,需要实时展示部署过程中的信息,或者在浏览器中展示程序日志,让开发者实时查看。你还在使用ajax定期获取服务器日志吗?出来,尝试使用 websocket 方法

我使用bottle框架写了一个websocket服务器,浏览器连接websocket服务器,然后使用python子进程获取远程服务器的日志信息。子进程就是用Popen调用shell的shell命令,这样就可以得到实时的日志。,然后发送到websocket服务器,连接到websocket服务器的浏览器会实时显示

用两台服务器来实现这个场景,服务器A是websocket服务器,服务器B是日志

A服务器是我浏览器的本地机器,websocket服务器也是这台机器。IP为:192.168.1.221

服务器B是远程查看日志的服务器,我这里用的是:192.168.1.10

以下是A服务器的websocket servert的python代码:

#!/usr/bin/envpython#coding=utf-8#__author__='戴儒锋'#"""Pipinstallbottlepipinstallwebsocket-clientpipinstallbottle-websocket"""frombottleimportget,runfrombottle.ext.websocketimportGeventWebSocketServerfrombottle.ext.websocketusers=importwebsocketsetusers=importwebsocketset 必须安装执行代码前()#连接websocket客户端集合@get('/websocket/',apply=[websocket])defchat(ws):users.add(ws)whileTrue:msg=ws.receive()#接收客户端的message ifmsg:foruinusers:u.send(msg)#向所有客户端发送信息 else:break#如果客户端断开连接,踢出用户设置 users.remove(ws)run(host='0.@ >0. @>0.@>0',port=8000,server=GeventWebSocketServer)

记得安装bottle、websocket-client 和bottle-websocket 模块。服务器允许所有IP访问其8000端口

除了以上方法,websocket服务端还可以通过以下方法实现:

使用gevent-websocket实现websocket服务端程序

在电脑桌面上,写一个简单的HTML5 javascripts页面,随便起个名字,比如web_socket.html。此页面使用 websocket 连接到 websocket 服务器:

实时日志

“味精”>

注意:WebSocket('ws://192.168.1.221:8000/websocket/'); 这里192.168.1.221一定要改成你的websocket服务器IP,切记!!!

至此,浏览器连接到了websocket服务器。现在我们需要在A服务器写一段代码,去采集B服务器的实时信息。其实采集的原理很简单。就是使用shell。在tailf命令中,实时显示最新信息。在这个脚本中,我们使用 subprocess.Popen() 来远程查看日志信息:

python代码如下:

#!/usr/bin/python#encoding=utf-8importsubprocessimporttimefromwebsocketimportcreate_connection#配置远程服务器的IP、账号、密码、端口等。因为我做了双机密钥信任,不需要密码 r_user="root"r_ip="192.168.1.10"r_port=22r_log="/tmp/ web_socket.log" #远程服务器的日志路径为采集#websocket服务器地址 ws_server ="ws://192.168.1.221:8000 /websocket/"#Shell 命令执行(使用ssh远程执行) cmd="/usr/bin/ssh -p{port}{user}@{ip}/usr/bin/tailf{log_path}".format(user =r_user,ip=r_ip,port=r_port,log_path=r_log)deftailfLog():"""获取远程服务器实时日志,并发送给websocket服务器"""popen=subprocess。

文章最后分析subprocess.Popen的原理和作用

执行websocket服务端脚本和上面的websocket客户端采集脚本,然后用浏览器打开上面的html5页面,环境基本部署完毕,双websocket客户端连接websocket服务端

上面脚本指定的r_log="/tmp/web_socket.log"日志路径,我们需要生成这个日志文件并不断的往里面写入日志,这样效果才能在浏览器中实时显示(在真实场景中) ,可以指定服务器的A日志,如apache、nginx日志等)

我们在B服务器上写一段python代码,然后每隔一秒在r_log="/tmp/web_socket.log"日志中写入内容:

python代码如下:

#!/usr/bin/envpython#coding=utf-8importtimeimportrandomlog_path='/tmp/web_socket.log'while1:withopen(log_path,'a')asf:f.write('[%s]%s\n'% (time.ctime(),random.random()))time.sleep(1)

脚本写的内容大概是:

[2016 年 7 月 26 日星期二 18:30:41] 0.@>527242649654

[2016 年 7 月 26 日星期二 18:30:42] 0.@>21080845298

[2016 年 7 月 26 日星期二 18:30:43] 0.@>23128691356

[2016 年 7 月 26 日星期二 18:30:44] 0.@>689547600796

执行这个脚本,然后查看浏览器效果:

这是我临时写的。如果要在真正的运维工具中使用,需要根据具体情况修改很多内容,但原理是这样的。可以根据自己的情况修改完善使用。

刚才提到了subprocess.Popen的原理和作用,请看以下资料:

瓶装websocket参考资料: 查看全部

实时抓取网页数据(用websocket技术,在运维工具的浏览器上实时显示远程服务器上的日志信息)

功能:使用websocket技术,在运维工具的浏览器上实时显示远程服务器上的日志信息

一般我们在部署运维工具的环境时,需要实时展示部署过程中的信息,或者在浏览器中展示程序日志,让开发者实时查看。你还在使用ajax定期获取服务器日志吗?出来,尝试使用 websocket 方法

我使用bottle框架写了一个websocket服务器,浏览器连接websocket服务器,然后使用python子进程获取远程服务器的日志信息。子进程就是用Popen调用shell的shell命令,这样就可以得到实时的日志。,然后发送到websocket服务器,连接到websocket服务器的浏览器会实时显示

用两台服务器来实现这个场景,服务器A是websocket服务器,服务器B是日志

A服务器是我浏览器的本地机器,websocket服务器也是这台机器。IP为:192.168.1.221

服务器B是远程查看日志的服务器,我这里用的是:192.168.1.10

以下是A服务器的websocket servert的python代码:

#!/usr/bin/envpython#coding=utf-8#__author__='戴儒锋'#"""Pipinstallbottlepipinstallwebsocket-clientpipinstallbottle-websocket"""frombottleimportget,runfrombottle.ext.websocketimportGeventWebSocketServerfrombottle.ext.websocketusers=importwebsocketsetusers=importwebsocketset 必须安装执行代码前()#连接websocket客户端集合@get('/websocket/',apply=[websocket])defchat(ws):users.add(ws)whileTrue:msg=ws.receive()#接收客户端的message ifmsg:foruinusers:u.send(msg)#向所有客户端发送信息 else:break#如果客户端断开连接,踢出用户设置 users.remove(ws)run(host='0.@ >0. @>0.@>0',port=8000,server=GeventWebSocketServer)

记得安装bottle、websocket-client 和bottle-websocket 模块。服务器允许所有IP访问其8000端口

除了以上方法,websocket服务端还可以通过以下方法实现:

使用gevent-websocket实现websocket服务端程序

在电脑桌面上,写一个简单的HTML5 javascripts页面,随便起个名字,比如web_socket.html。此页面使用 websocket 连接到 websocket 服务器:

实时日志

“味精”>

注意:WebSocket('ws://192.168.1.221:8000/websocket/'); 这里192.168.1.221一定要改成你的websocket服务器IP,切记!!!

至此,浏览器连接到了websocket服务器。现在我们需要在A服务器写一段代码,去采集B服务器的实时信息。其实采集的原理很简单。就是使用shell。在tailf命令中,实时显示最新信息。在这个脚本中,我们使用 subprocess.Popen() 来远程查看日志信息:

python代码如下:

#!/usr/bin/python#encoding=utf-8importsubprocessimporttimefromwebsocketimportcreate_connection#配置远程服务器的IP、账号、密码、端口等。因为我做了双机密钥信任,不需要密码 r_user="root"r_ip="192.168.1.10"r_port=22r_log="/tmp/ web_socket.log" #远程服务器的日志路径为采集#websocket服务器地址 ws_server ="ws://192.168.1.221:8000 /websocket/"#Shell 命令执行(使用ssh远程执行) cmd="/usr/bin/ssh -p{port}{user}@{ip}/usr/bin/tailf{log_path}".format(user =r_user,ip=r_ip,port=r_port,log_path=r_log)deftailfLog():"""获取远程服务器实时日志,并发送给websocket服务器"""popen=subprocess。

文章最后分析subprocess.Popen的原理和作用

执行websocket服务端脚本和上面的websocket客户端采集脚本,然后用浏览器打开上面的html5页面,环境基本部署完毕,双websocket客户端连接websocket服务端

上面脚本指定的r_log="/tmp/web_socket.log"日志路径,我们需要生成这个日志文件并不断的往里面写入日志,这样效果才能在浏览器中实时显示(在真实场景中) ,可以指定服务器的A日志,如apache、nginx日志等)

我们在B服务器上写一段python代码,然后每隔一秒在r_log="/tmp/web_socket.log"日志中写入内容:

python代码如下:

#!/usr/bin/envpython#coding=utf-8importtimeimportrandomlog_path='/tmp/web_socket.log'while1:withopen(log_path,'a')asf:f.write('[%s]%s\n'% (time.ctime(),random.random()))time.sleep(1)

脚本写的内容大概是:

[2016 年 7 月 26 日星期二 18:30:41] 0.@>527242649654

[2016 年 7 月 26 日星期二 18:30:42] 0.@>21080845298

[2016 年 7 月 26 日星期二 18:30:43] 0.@>23128691356

[2016 年 7 月 26 日星期二 18:30:44] 0.@>689547600796

执行这个脚本,然后查看浏览器效果:

这是我临时写的。如果要在真正的运维工具中使用,需要根据具体情况修改很多内容,但原理是这样的。可以根据自己的情况修改完善使用。

刚才提到了subprocess.Popen的原理和作用,请看以下资料:

瓶装websocket参考资料:

实时抓取网页数据(WEBCRAWLER网络爬虫实训项目1WEBCRAWLER网络爬虫实训项目)

网站优化 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2021-09-26 14:14

WEBCRAWLER 网络爬虫培训项目1 WEBCRAWLER 网络爬虫培训项目文档版本:1.0.0.1 作者:Dane IT Training Group C++教学研发部作者:Min Wei 定稿日期:11月,星期五20, 2015 WEBCRAWLER 网络爬虫培训项目21. 项目概述 互联网产品种类繁多,以产品为导向,以营销为导向,以技术为导向,但精通技术的互联网产品占比较高。较小。搜索引擎是目前互联网产品中技术含量最高的产品,如果不是唯一的,至少也是其中之一。经过十多年的发展,搜索引擎已经成为互联网的重要门户之一。Twitter联合创始人埃文威廉姆斯提出“

这样的海WEBCRAWLER网络爬虫训练项目3的数据如何获取、存储和计算?如何快速响应用户查询?如何使搜索结果尽可能满足用户对信息的需求?这些都是搜索引擎设计者必须面对的技术挑战。下图展示了一个通用搜索引擎的基本结构。商业级搜索引擎通常由许多独立的模块组成。每个模块只负责搜索引擎的部分功能,相互配合形成一个完整的搜索引擎:搜索引擎的信息源来自互联网网页,整个“网络爬虫”的信息在本地获取“Internet”,由于互联网页面的大部分内容完全相同或几乎重复,“网页重复数据删除”模块会检测到并删除重复的内容。之后,搜索引擎会解析网页,提取网页的主要内容,以及指向该网页中收录的其他页面的所谓超链接。为了加快用户查询的响应速度,通过高效的“倒排索引”查询数据结构保存网页内容,同时保存网页之间的链接关系。之所以保存链接关系,是因为这个关系在网页的相关性排名阶段是可用的。页面的相对重要性可以通过“链接分析”来判断,这对于为用户提供准确的搜索结果非常有帮助。由于网页数量众多,搜索引擎不仅需要保存网页的原创信息,还需要保存一些中间处理结果。使用单台计算机或少量计算机显然是不现实的。

谷歌等商业搜索引擎提供商为此开发了一套完整的云存储和云计算平台,利用数以万计的普通PCWEBCRAWLER网络爬虫训练项目4,构建了海量信息作为搜索的可靠存储和计算架构引擎及其相关应用的基础支持。优秀的云存储和云计算平台已成为大型商业搜索引擎的核心竞争力。以上就是搜索引擎获取和存储海量网页相关信息的方式。这些功能不需要实时计算,可以看作是搜索引擎的后端计算系统。搜索引擎的首要目标当然是为用户提供准确、全面的搜索结果。因此,实时响应用户查询并提供准确结果构成了搜索引擎的前端计算系统。当搜索引擎收到用户的查询请求时,首先需要对查询词进行分析,并通过与用户信息的结合,正确推断出用户的真实搜索意图。之后,首先查看“缓存系统”维护的缓存。搜索引擎的缓存中存储着不同的搜索意图及其对应的搜索结果。如果在缓存中找到满足用户需求的信息,则直接将搜索结果返回给用户。这不仅节省了重复计算的资源消耗,同时也加快了整个搜索过程的响应速度。如果缓存中没有找到满足用户需求的信息,则需要使用“页面排序”,根据用户的搜索意图实时计算哪些网页满足用户需求,排序输出作为搜索结果。

网页排名最重要的两个参考因素是“内容相似度”,即哪些网页与用户的搜索意图密切相关;另一个是网页重要性,即哪些网页质量好或者比较重要。这通常可以从“链接分析”的结果中获得。结合以上两个考虑,前端系统将网页进行排序,作为搜索的最终结果。除了上述功能模块外,搜索引擎的“反作弊”模块近年来也越来越受到关注。搜索引擎作为网民上网的门户,对网络流量的引导和分流至关重要,甚至可以说起到了举足轻重的作用。因此,各种“作弊” 方法逐渐流行起来。使用各种方法将网页的搜索排名提升到与网页质量不相称的位置,这将严重影响用户的搜索体验。因此,如何自动发现作弊网页并给予相应的惩罚,成为搜索引擎非常重要的功能之一。1.2. 网络爬虫通用搜索引擎的处理对象是互联网网页。目前网页有数百万个,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统。将如此大量的网页数据发送到本地,在本地形成互联 使用各种方法将网页的搜索排名提升到与网页质量不相称的位置,这将严重影响用户的搜索体验。因此,如何自动发现作弊网页并给予相应的惩罚,成为搜索引擎非常重要的功能之一。1.2. 网络爬虫通用搜索引擎的处理对象是互联网网页。目前网页有数百万个,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统。将如此大量的网页数据发送到本地,在本地形成互联 使用各种方法将网页的搜索排名提升到与网页质量不相称的位置,这将严重影响用户的搜索体验。因此,如何自动发现作弊网页并给予相应的惩罚,成为搜索引擎非常重要的功能之一。1.2. 网络爬虫通用搜索引擎的处理对象是互联网网页。目前网页有数百万个,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统。将如此大量的网页数据发送到本地,在本地形成互联 如何自动发现作弊网页并给予相应的惩罚已经成为搜索引擎非常重要的功能之一。1.2. 网络爬虫通用搜索引擎的处理对象是互联网网页。目前网页有数百万个,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统。将如此大量的网页数据发送到本地,在本地形成互联 如何自动发现作弊网页并给予相应的惩罚已经成为搜索引擎非常重要的功能之一。1.2. 网络爬虫通用搜索引擎的处理对象是互联网网页。目前网页有数百万个,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统。将如此大量的网页数据发送到本地,在本地形成互联 查看全部

实时抓取网页数据(WEBCRAWLER网络爬虫实训项目1WEBCRAWLER网络爬虫实训项目)

WEBCRAWLER 网络爬虫培训项目1 WEBCRAWLER 网络爬虫培训项目文档版本:1.0.0.1 作者:Dane IT Training Group C++教学研发部作者:Min Wei 定稿日期:11月,星期五20, 2015 WEBCRAWLER 网络爬虫培训项目21. 项目概述 互联网产品种类繁多,以产品为导向,以营销为导向,以技术为导向,但精通技术的互联网产品占比较高。较小。搜索引擎是目前互联网产品中技术含量最高的产品,如果不是唯一的,至少也是其中之一。经过十多年的发展,搜索引擎已经成为互联网的重要门户之一。Twitter联合创始人埃文威廉姆斯提出“

这样的海WEBCRAWLER网络爬虫训练项目3的数据如何获取、存储和计算?如何快速响应用户查询?如何使搜索结果尽可能满足用户对信息的需求?这些都是搜索引擎设计者必须面对的技术挑战。下图展示了一个通用搜索引擎的基本结构。商业级搜索引擎通常由许多独立的模块组成。每个模块只负责搜索引擎的部分功能,相互配合形成一个完整的搜索引擎:搜索引擎的信息源来自互联网网页,整个“网络爬虫”的信息在本地获取“Internet”,由于互联网页面的大部分内容完全相同或几乎重复,“网页重复数据删除”模块会检测到并删除重复的内容。之后,搜索引擎会解析网页,提取网页的主要内容,以及指向该网页中收录的其他页面的所谓超链接。为了加快用户查询的响应速度,通过高效的“倒排索引”查询数据结构保存网页内容,同时保存网页之间的链接关系。之所以保存链接关系,是因为这个关系在网页的相关性排名阶段是可用的。页面的相对重要性可以通过“链接分析”来判断,这对于为用户提供准确的搜索结果非常有帮助。由于网页数量众多,搜索引擎不仅需要保存网页的原创信息,还需要保存一些中间处理结果。使用单台计算机或少量计算机显然是不现实的。

谷歌等商业搜索引擎提供商为此开发了一套完整的云存储和云计算平台,利用数以万计的普通PCWEBCRAWLER网络爬虫训练项目4,构建了海量信息作为搜索的可靠存储和计算架构引擎及其相关应用的基础支持。优秀的云存储和云计算平台已成为大型商业搜索引擎的核心竞争力。以上就是搜索引擎获取和存储海量网页相关信息的方式。这些功能不需要实时计算,可以看作是搜索引擎的后端计算系统。搜索引擎的首要目标当然是为用户提供准确、全面的搜索结果。因此,实时响应用户查询并提供准确结果构成了搜索引擎的前端计算系统。当搜索引擎收到用户的查询请求时,首先需要对查询词进行分析,并通过与用户信息的结合,正确推断出用户的真实搜索意图。之后,首先查看“缓存系统”维护的缓存。搜索引擎的缓存中存储着不同的搜索意图及其对应的搜索结果。如果在缓存中找到满足用户需求的信息,则直接将搜索结果返回给用户。这不仅节省了重复计算的资源消耗,同时也加快了整个搜索过程的响应速度。如果缓存中没有找到满足用户需求的信息,则需要使用“页面排序”,根据用户的搜索意图实时计算哪些网页满足用户需求,排序输出作为搜索结果。

网页排名最重要的两个参考因素是“内容相似度”,即哪些网页与用户的搜索意图密切相关;另一个是网页重要性,即哪些网页质量好或者比较重要。这通常可以从“链接分析”的结果中获得。结合以上两个考虑,前端系统将网页进行排序,作为搜索的最终结果。除了上述功能模块外,搜索引擎的“反作弊”模块近年来也越来越受到关注。搜索引擎作为网民上网的门户,对网络流量的引导和分流至关重要,甚至可以说起到了举足轻重的作用。因此,各种“作弊” 方法逐渐流行起来。使用各种方法将网页的搜索排名提升到与网页质量不相称的位置,这将严重影响用户的搜索体验。因此,如何自动发现作弊网页并给予相应的惩罚,成为搜索引擎非常重要的功能之一。1.2. 网络爬虫通用搜索引擎的处理对象是互联网网页。目前网页有数百万个,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统。将如此大量的网页数据发送到本地,在本地形成互联 使用各种方法将网页的搜索排名提升到与网页质量不相称的位置,这将严重影响用户的搜索体验。因此,如何自动发现作弊网页并给予相应的惩罚,成为搜索引擎非常重要的功能之一。1.2. 网络爬虫通用搜索引擎的处理对象是互联网网页。目前网页有数百万个,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统。将如此大量的网页数据发送到本地,在本地形成互联 使用各种方法将网页的搜索排名提升到与网页质量不相称的位置,这将严重影响用户的搜索体验。因此,如何自动发现作弊网页并给予相应的惩罚,成为搜索引擎非常重要的功能之一。1.2. 网络爬虫通用搜索引擎的处理对象是互联网网页。目前网页有数百万个,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统。将如此大量的网页数据发送到本地,在本地形成互联 如何自动发现作弊网页并给予相应的惩罚已经成为搜索引擎非常重要的功能之一。1.2. 网络爬虫通用搜索引擎的处理对象是互联网网页。目前网页有数百万个,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统。将如此大量的网页数据发送到本地,在本地形成互联 如何自动发现作弊网页并给予相应的惩罚已经成为搜索引擎非常重要的功能之一。1.2. 网络爬虫通用搜索引擎的处理对象是互联网网页。目前网页有数百万个,搜索引擎面临的第一个问题就是如何设计一个高效的下载系统。将如此大量的网页数据发送到本地,在本地形成互联

实时抓取网页数据(httpclient+jsoup提取网页数据的分类汇总,值得收藏!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 104 次浏览 • 2021-09-23 08:14

在许多行业中,必须行业的数据进行分类,分析行业数据。对于公司未来的发展,有一个很好的参考和横向对比。因此,在实际工作中,我们可能会遇到数据采集这个概念,数据采集的最终目标是获取数据,提取数据提取和数据分类汇总有用的数据。

很多人都在第一时间我学到的数据采集,我可能无法启动,特别是作为一个新手,但我觉得很别扭,所以我将分享我自己的经验,我希望能够分享技术与每一个人。如果有任何不足之处,请参考你。写这个目的,我希望每个人都会成长,我也相信,没有高低,只有互补,仅共享,可以使对方变得更加。

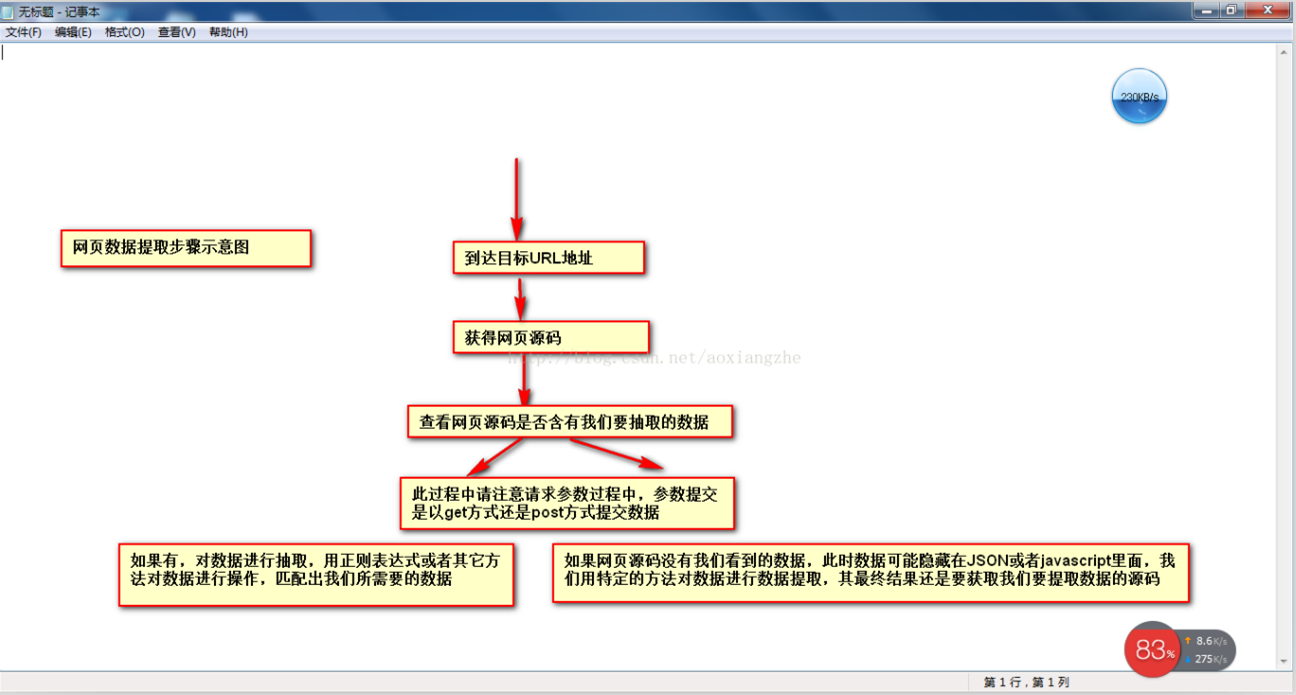

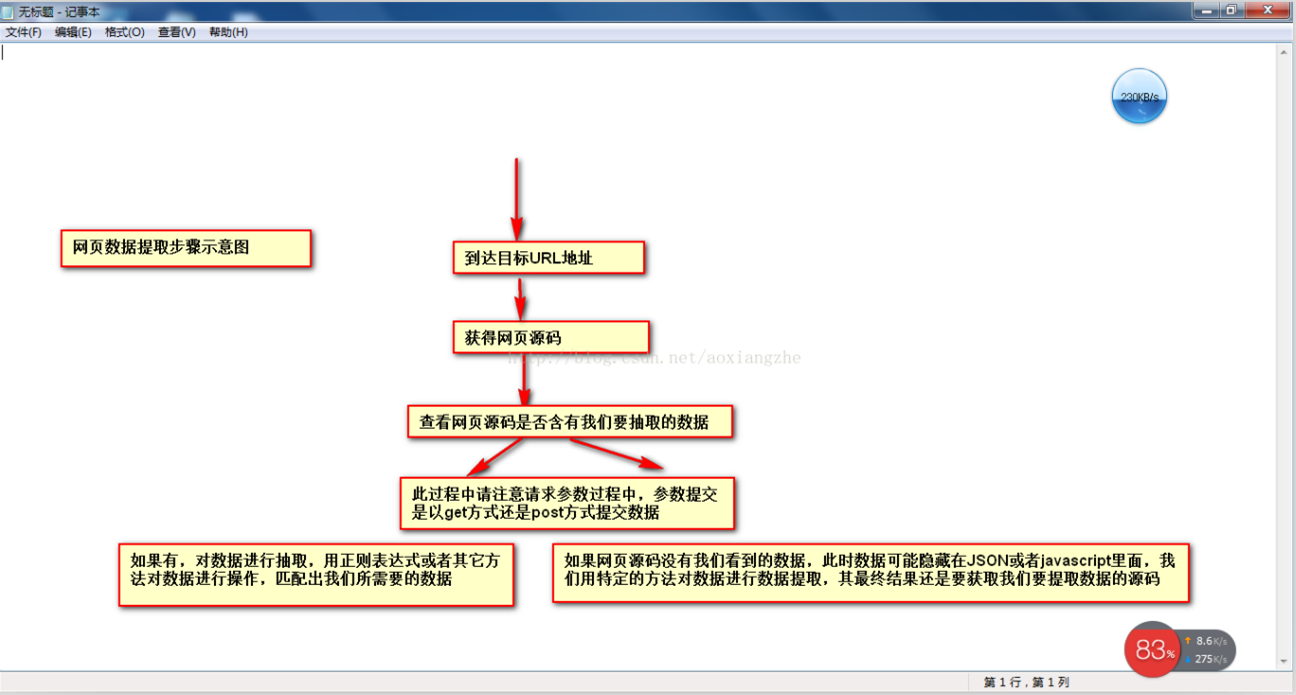

当我们在Web数据采集,我们倾向于穿过这些大步骤:

1通过URL地址2获得幅材源代码3提取物,我们有通过网络的源代码4以提取对数据进行格式化,以获得我们所需要的数据的目标数据中读取目标页面。

这是一个示意图,我希望每个人都知道

了解基本的过程,下来,我知道如何提取我们需要的情况下的数据,并提取数据提取可以用正则表达式中提取,或使用的HttpClient + JSOUP中提取,在这里,不解释HttpClient的+ JSou提取有关网络数据信息,将使了HTTPClient + JSou的专项说明后,在这里,开始讲解如何使用正则表达式提取数据。

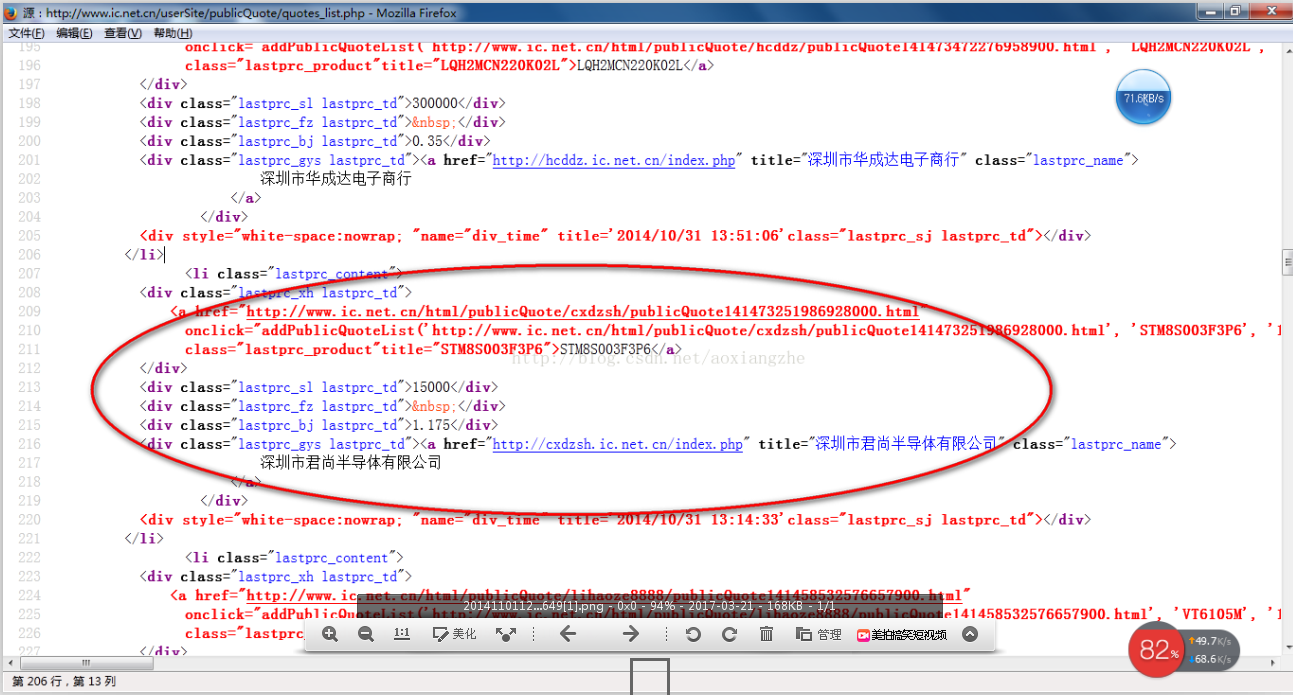

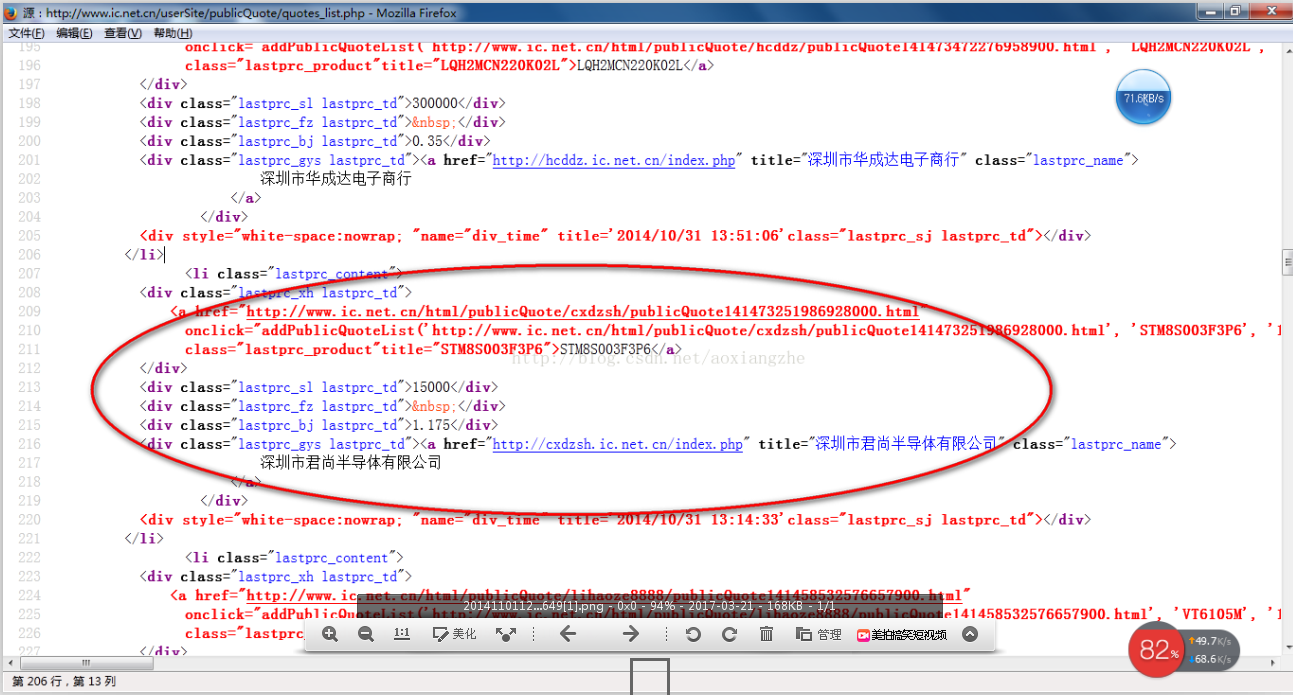

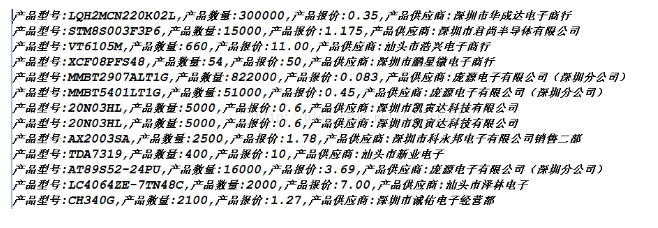

我在这里找到了网站:我们要提取里面的数据,最终的结果,我们不得不提的是型号,数量,报价,供应商,首先我们看到的这款网站整个页预览

接下来,我们看一下在网络源结构:

上面的源代码可以清楚明确,我们将提取整个网络数据为整个网页数据。

import java.io.BufferedReader;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class HTMLPageParser {

public static void main(String[] args) throws Exception {

//目的网页URL地址

getURLInfo("http://www.ic.net.cn/userSite/ ... ot%3B,"utf-8");

}

public static List getURLInfo(String urlInfo,String charset) throws Exception {

//读取目的网页URL地址,获取网页源码

URL url = new URL(urlInfo);

HttpURLConnection httpUrl = (HttpURLConnection)url.openConnection();

InputStream is = httpUrl.getInputStream();

BufferedReader br = new BufferedReader(new InputStreamReader(is,"utf-8"));

StringBuilder sb = new StringBuilder();

String line;

while ((line = br.readLine()) != null) {

//这里是对链接进行处理

line = line.replaceAll("]*>", "");

//这里是对样式进行处理

line = line.replaceAll("]*>", "");

sb.append(line);

}

is.close();

br.close();

//获得网页源码

return getDataStructure(sb.toString().trim());

}

static Pattern proInfo

= Pattern.compile("(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)", Pattern.DOTALL);

private static List getDataStructure(String str) {

//运用正则表达式对获取的网页源码进行数据匹配,提取我们所要的数据,在以后的过程中,我们可以采用httpclient+jsoup,

//现在暂时运用正则表达式对数据进行抽取提取

String[] info = str.split("");

List list = new ArrayList();

for (String s : info) {

Matcher m = proInfo.matcher(s);

Product p = null;

if (m.find()) {

p = new Product();

//设置产品型号

String[] ss = m.group(1).trim().replace(" ", "").split(">");

p.setProStyle(ss[1]);

//设置产品数量

p.setProAmount(m.group(2).trim().replace(" ", ""));

//设置产品报价

p.setProPrice(m.group(4).trim().replace(" ", ""));

//设置产品供应商

p.setProSupplier(m.group(5).trim().replace(" ", ""));

list.add(p);

}

}

//这里对集合里面不是我们要提取的数据进行移除

list.remove(0);

for (int i = 0; i < list.size(); i++) {

System.out.println("产品型号:"+list.get(i).getProStyle()+",产品数量:"+list.get(i).getProAmount()

+",产品报价:"+list.get(i).getProPrice()+",产品供应商:"+list.get(i).getProSupplier());

}

return list;

}

}

class Product {

private String proStyle;//产品型号

private String proAmount;//产品数量

private String proPrice;//产品报价

private String proSupplier;//产品供应商

public String getProStyle() {

return proStyle;

}

public void setProStyle(String proStyle) {

this.proStyle = proStyle;

}

public String getProSupplier() {

return proSupplier;

}

public void setProSupplier(String proSupplier) {

this.proSupplier = proSupplier;

}

public String getProAmount() {

return proAmount;

}

public void setProAmount(String proAmount) {

this.proAmount = proAmount;

}

public String getProPrice() {

return proPrice;

}

public void setProPrice(String proPrice) {

this.proPrice = proPrice;

}

public Product() {

}

@Override

public String toString() {

return "Product [proAmount=" + proAmount + ", proPrice=" + proPrice

+ ", proStyle=" + proStyle + ", proSupplier=" + proSupplier

+ "]";

}

}

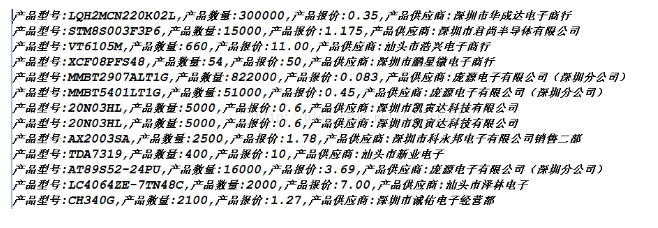

确定,运行上述程序,我们得到以下数据,即,我们有最终数据以获得

获取数据的成功,这就是我们要得到最终的数据结果,最后我想说,这个页面比较简单,和网络源代码,可以看到源的数据,这种方式是GET模式当数据被提交,当采集,一些网络结构比较复杂,并且可能没有数据,我们必须在源代码中提取。关于此解决方案,稍后为您介绍。另外,我在采集这个页面,只需采集@@ķ数据数据的数据数据,这一点,我不解释在这里,只是提示,我们可以使用多线程到所有当前的数据分页采集,通过线程一个采集当前页面的数据,一个翻页动作,你可以采集完成所有的数据。

我们匹配的数据可能会在项目的实际开发中,需要我们做存储所提取的数据资料,以便我们将在接下来的数据进行数据。 查看全部

实时抓取网页数据(httpclient+jsoup提取网页数据的分类汇总,值得收藏!)

在许多行业中,必须行业的数据进行分类,分析行业数据。对于公司未来的发展,有一个很好的参考和横向对比。因此,在实际工作中,我们可能会遇到数据采集这个概念,数据采集的最终目标是获取数据,提取数据提取和数据分类汇总有用的数据。

很多人都在第一时间我学到的数据采集,我可能无法启动,特别是作为一个新手,但我觉得很别扭,所以我将分享我自己的经验,我希望能够分享技术与每一个人。如果有任何不足之处,请参考你。写这个目的,我希望每个人都会成长,我也相信,没有高低,只有互补,仅共享,可以使对方变得更加。

当我们在Web数据采集,我们倾向于穿过这些大步骤:

1通过URL地址2获得幅材源代码3提取物,我们有通过网络的源代码4以提取对数据进行格式化,以获得我们所需要的数据的目标数据中读取目标页面。

这是一个示意图,我希望每个人都知道

了解基本的过程,下来,我知道如何提取我们需要的情况下的数据,并提取数据提取可以用正则表达式中提取,或使用的HttpClient + JSOUP中提取,在这里,不解释HttpClient的+ JSou提取有关网络数据信息,将使了HTTPClient + JSou的专项说明后,在这里,开始讲解如何使用正则表达式提取数据。

我在这里找到了网站:我们要提取里面的数据,最终的结果,我们不得不提的是型号,数量,报价,供应商,首先我们看到的这款网站整个页预览

接下来,我们看一下在网络源结构:

上面的源代码可以清楚明确,我们将提取整个网络数据为整个网页数据。

import java.io.BufferedReader;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class HTMLPageParser {

public static void main(String[] args) throws Exception {

//目的网页URL地址

getURLInfo("http://www.ic.net.cn/userSite/ ... ot%3B,"utf-8");

}

public static List getURLInfo(String urlInfo,String charset) throws Exception {

//读取目的网页URL地址,获取网页源码

URL url = new URL(urlInfo);

HttpURLConnection httpUrl = (HttpURLConnection)url.openConnection();

InputStream is = httpUrl.getInputStream();

BufferedReader br = new BufferedReader(new InputStreamReader(is,"utf-8"));

StringBuilder sb = new StringBuilder();

String line;

while ((line = br.readLine()) != null) {

//这里是对链接进行处理

line = line.replaceAll("]*>", "");

//这里是对样式进行处理

line = line.replaceAll("]*>", "");

sb.append(line);

}

is.close();

br.close();

//获得网页源码

return getDataStructure(sb.toString().trim());

}

static Pattern proInfo

= Pattern.compile("(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)", Pattern.DOTALL);

private static List getDataStructure(String str) {

//运用正则表达式对获取的网页源码进行数据匹配,提取我们所要的数据,在以后的过程中,我们可以采用httpclient+jsoup,

//现在暂时运用正则表达式对数据进行抽取提取

String[] info = str.split("");

List list = new ArrayList();

for (String s : info) {

Matcher m = proInfo.matcher(s);

Product p = null;

if (m.find()) {

p = new Product();

//设置产品型号

String[] ss = m.group(1).trim().replace(" ", "").split(">");

p.setProStyle(ss[1]);

//设置产品数量

p.setProAmount(m.group(2).trim().replace(" ", ""));

//设置产品报价

p.setProPrice(m.group(4).trim().replace(" ", ""));

//设置产品供应商

p.setProSupplier(m.group(5).trim().replace(" ", ""));

list.add(p);

}

}

//这里对集合里面不是我们要提取的数据进行移除

list.remove(0);

for (int i = 0; i < list.size(); i++) {

System.out.println("产品型号:"+list.get(i).getProStyle()+",产品数量:"+list.get(i).getProAmount()

+",产品报价:"+list.get(i).getProPrice()+",产品供应商:"+list.get(i).getProSupplier());

}

return list;

}

}

class Product {

private String proStyle;//产品型号

private String proAmount;//产品数量

private String proPrice;//产品报价

private String proSupplier;//产品供应商

public String getProStyle() {

return proStyle;

}

public void setProStyle(String proStyle) {

this.proStyle = proStyle;

}

public String getProSupplier() {

return proSupplier;

}

public void setProSupplier(String proSupplier) {

this.proSupplier = proSupplier;

}

public String getProAmount() {

return proAmount;

}

public void setProAmount(String proAmount) {

this.proAmount = proAmount;

}

public String getProPrice() {

return proPrice;

}

public void setProPrice(String proPrice) {

this.proPrice = proPrice;

}

public Product() {

}

@Override

public String toString() {

return "Product [proAmount=" + proAmount + ", proPrice=" + proPrice

+ ", proStyle=" + proStyle + ", proSupplier=" + proSupplier

+ "]";

}

}

确定,运行上述程序,我们得到以下数据,即,我们有最终数据以获得

获取数据的成功,这就是我们要得到最终的数据结果,最后我想说,这个页面比较简单,和网络源代码,可以看到源的数据,这种方式是GET模式当数据被提交,当采集,一些网络结构比较复杂,并且可能没有数据,我们必须在源代码中提取。关于此解决方案,稍后为您介绍。另外,我在采集这个页面,只需采集@@ķ数据数据的数据数据,这一点,我不解释在这里,只是提示,我们可以使用多线程到所有当前的数据分页采集,通过线程一个采集当前页面的数据,一个翻页动作,你可以采集完成所有的数据。

我们匹配的数据可能会在项目的实际开发中,需要我们做存储所提取的数据资料,以便我们将在接下来的数据进行数据。

实时抓取网页数据(中国地震台网教你如何获取别人网站的数据?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2021-09-22 10:21

通常我们知道,有3种方法可以获得别人网站

1:小偷程序直接,然后另一方网站 HTML标记中的数据也可以与CURL

一起使用

如果您遇到登录。

2:另一方提供API,我们获取JSON XML格式获取HTTP(WebServices)

3:直接手动副本。 。 。

---------------------------------------- --------------------------------------------- -------------

我们知道您可以收录2种

1:实时读数,当其他人运行我们的网站,询问别人@ @ @ @ @ @ @ @ @ @ @ @ @

2:首先来,输入我们的数据库,然后从我们的数据库中读取它

所以我可以问,这是你使用的方式采集?

一般每个人如果要保存库,是否有必要请求每秒彼此数据?

000

描述联赛:

中国地震网络

我想成为网站,其中一些页面留给div框,做一个实时全局地震数据

无法在上一段时间内保存,后来肯定会保存仓库,但保存库的实时也不高,你不能每秒互相查询

如果另一方不提供API。方法 查看全部

实时抓取网页数据(中国地震台网教你如何获取别人网站的数据?)

通常我们知道,有3种方法可以获得别人网站

1:小偷程序直接,然后另一方网站 HTML标记中的数据也可以与CURL

一起使用

如果您遇到登录。

2:另一方提供API,我们获取JSON XML格式获取HTTP(WebServices)

3:直接手动副本。 。 。

---------------------------------------- --------------------------------------------- -------------

我们知道您可以收录2种

1:实时读数,当其他人运行我们的网站,询问别人@ @ @ @ @ @ @ @ @ @ @ @ @

2:首先来,输入我们的数据库,然后从我们的数据库中读取它

所以我可以问,这是你使用的方式采集?

一般每个人如果要保存库,是否有必要请求每秒彼此数据?

000

描述联赛:

中国地震网络

我想成为网站,其中一些页面留给div框,做一个实时全局地震数据

无法在上一段时间内保存,后来肯定会保存仓库,但保存库的实时也不高,你不能每秒互相查询

如果另一方不提供API。方法

实时抓取网页数据(【漫画】如何成为一个有意思的人?(上))

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2021-09-20 18:37

.打开“GET”,SURL,False

.发送

'tt=.responseBody

tt=.responseText

'tt=StrConv(.responsebody,vbUnicode)

以

如果仪表(tt,“Sheet1.Cells(i,13)=Split(Split)(拆分)(tt,“”)(0),“>”)(1)

否则

Sheet1.Cells(i,13)=“-”

如果结束

如果仪表(TT“”),则“获取标题”

Sheet1.Cells(i,14)=阀内件(更换(分体式)(分体式)(tt,“”(1),“”(0),vbLf,“”)))

否则

Sheet1.Cells(i,14)=“-”

如果结束

如果instr(TT,“”),则“获取注释”

Sheet1.Cells(i,15)拆分(拆分)(拆分)(tt,“”(1),“”(0),“”)(0)

否则

Sheet1.Cells(i,15)@=0

如果结束

如果仪表(tt,“Sheet1.Cells(i,16)拆分(拆分)(拆分)(拆分)(tt)(0),“title=”)(1)),”)(0)

否则

Sheet1.Cells(i,16)@=0

如果结束

如果仪表(tt,“Sheet1.Cells(i,17)=拆分(替换拆分)(拆分)(拆分(拆分)(拆分)(拆分)(拆分)(拆分)(tt,“”(0),“”(1),vbLf,“”)))(0)

否则

Sheet1.Cells(i,17)=0

如果结束

如果仪表(tt,“Sheet1.Cells(i,18)=Split(Split)(拆分)(tt,“”)(0),“>”)(1)

否则

Sheet1.Cells(i,18)=0

如果结束

如果仪表(TT“”),则“抓取类别”

Sheet1.Cells(i,19)拆分(拆分)(拆分)(拆分)(拆分)(拆分)(拆分)(拆分)(tt)(1):“”)(0):“in”)(1):“(”)(0):“,”和“))

否则

Sheet1.Cells(i,19)@=“-”

如果结束

如果仪表(TT“”),则“抓取BSR1

Sheet1.Cells(i,20)拆分(拆分)(拆分)(拆分)(tt,“”(1),in)(0),“#”)(1)

否则

Sheet1.Cells(i,20)=0

如果结束

如果instr(TT,“”),则“抓取节点”

Sheet1.Cells(i,21)这句话的意思是:分裂,分裂,分裂,分裂@

否则

Sheet1.Cells(i,21)=“-”

如果结束

如果仪表(TT“”),则“抓取bsr2

Sheet1.Cells(i,22)拆分(拆分)(拆分)(拆分)(拆分)(拆分)(拆分)(tt)(1):“”)(0):“”)(1):“”)(0):“”)(0):“”)(1):“”)(0):“”)(1)

否则

Sheet1.Cells(i,22)@=0

如果结束

接下来我

端接头

复制代码

以前可以正常抓取商品信息(标题、品牌、评论、明星…),但最近抓取有误,商品本来是英文界面和数据,抓取时变成中文内容,导致原代码操作错误,(正常浏览产品页面时也会出现这种现象,但我们只需修改网站语言设置,防止出现中文内容),请问:

你能在代码中指定一个浏览器,比如谷歌浏览器来捕获数据吗(我想知道代码是打开360页还是IE页面,这两个页面可能都有中文界面)

还是其他问题造成的

另外,我想在这段代码中添加setrequestheader,以避免网站反攀爬系统。我也希望得到老师的帮助

非常感谢你的帮助

бб 查看全部

实时抓取网页数据(【漫画】如何成为一个有意思的人?(上))

.打开“GET”,SURL,False

.发送

'tt=.responseBody

tt=.responseText

'tt=StrConv(.responsebody,vbUnicode)

以

如果仪表(tt,“Sheet1.Cells(i,13)=Split(Split)(拆分)(tt,“”)(0),“>”)(1)

否则

Sheet1.Cells(i,13)=“-”

如果结束

如果仪表(TT“”),则“获取标题”

Sheet1.Cells(i,14)=阀内件(更换(分体式)(分体式)(tt,“”(1),“”(0),vbLf,“”)))

否则

Sheet1.Cells(i,14)=“-”

如果结束

如果instr(TT,“”),则“获取注释”

Sheet1.Cells(i,15)拆分(拆分)(拆分)(tt,“”(1),“”(0),“”)(0)

否则

Sheet1.Cells(i,15)@=0

如果结束

如果仪表(tt,“Sheet1.Cells(i,16)拆分(拆分)(拆分)(拆分)(tt)(0),“title=”)(1)),”)(0)

否则

Sheet1.Cells(i,16)@=0

如果结束

如果仪表(tt,“Sheet1.Cells(i,17)=拆分(替换拆分)(拆分)(拆分(拆分)(拆分)(拆分)(拆分)(拆分)(tt,“”(0),“”(1),vbLf,“”)))(0)

否则

Sheet1.Cells(i,17)=0

如果结束

如果仪表(tt,“Sheet1.Cells(i,18)=Split(Split)(拆分)(tt,“”)(0),“>”)(1)

否则

Sheet1.Cells(i,18)=0

如果结束

如果仪表(TT“”),则“抓取类别”

Sheet1.Cells(i,19)拆分(拆分)(拆分)(拆分)(拆分)(拆分)(拆分)(拆分)(tt)(1):“”)(0):“in”)(1):“(”)(0):“,”和“))

否则

Sheet1.Cells(i,19)@=“-”

如果结束

如果仪表(TT“”),则“抓取BSR1

Sheet1.Cells(i,20)拆分(拆分)(拆分)(拆分)(tt,“”(1),in)(0),“#”)(1)

否则

Sheet1.Cells(i,20)=0

如果结束

如果instr(TT,“”),则“抓取节点”

Sheet1.Cells(i,21)这句话的意思是:分裂,分裂,分裂,分裂@

否则

Sheet1.Cells(i,21)=“-”

如果结束

如果仪表(TT“”),则“抓取bsr2

Sheet1.Cells(i,22)拆分(拆分)(拆分)(拆分)(拆分)(拆分)(拆分)(tt)(1):“”)(0):“”)(1):“”)(0):“”)(0):“”)(1):“”)(0):“”)(1)

否则

Sheet1.Cells(i,22)@=0

如果结束

接下来我

端接头

复制代码

以前可以正常抓取商品信息(标题、品牌、评论、明星…),但最近抓取有误,商品本来是英文界面和数据,抓取时变成中文内容,导致原代码操作错误,(正常浏览产品页面时也会出现这种现象,但我们只需修改网站语言设置,防止出现中文内容),请问:

你能在代码中指定一个浏览器,比如谷歌浏览器来捕获数据吗(我想知道代码是打开360页还是IE页面,这两个页面可能都有中文界面)

还是其他问题造成的

另外,我想在这段代码中添加setrequestheader,以避免网站反攀爬系统。我也希望得到老师的帮助

非常感谢你的帮助

бб

实时抓取网页数据(本文就用Java给大家演示如何抓取网站的数据:(1))

网站优化 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2021-09-20 09:30

原创链接:

有时,由于各种原因,我们需要采集a网站data,但由于网站data的不同,数据的显示方式略有不同

本文将使用java向您展示如何抓取网站数据:(1)抓取原创网页数据;(2)抓取网页JavaScript返回的数据)

一、抓取原创网页

在本例中,我们将从以下位置获取IP查询的结果:

步骤1:打开此页面并输入IP:111. 142. 55.73.点击查询按钮查看网页上显示的结果:

第二步:查看web源代码。我们可以看到源代码中有一段:

从这里可以看出,查询结果是在重新请求网页后显示的

我们来看看查询后的网址:

换言之,只要访问这样的网站,我们就可以得到IP查询的结果。接下来,看看代码:

[爪哇]

publicvoidcaptureHtml(Stringip)throwsException{StringstrURL=”“+ip;URLurl=newURL(strURL);HttpURLConnectionhttpConn=(HttpURLConnection)url.openConnection();InputStreamReaderinput=newInputStreamReader(httpConn.getInputStream(),“utf-8”);BufferedReaderBufferer=newBufferedReader(input);Stringline=“;StringBuilderContentBuff=newStringBuilder();while((line=bufrader.Readline())!=null){contentbuf.Append(line);}stringbuf=contentbuf.Tostring();intbeginix=buf.Indexof(“查询结果[”);intendix=buf.Indexof(“依次显示上述四项”);stringresult=buf.Substring(beginix,endix);system.Out.Println(“capturehtml的结果():“n”+结果”);}

使用httpurlconnection连接到网站,使用bufreader保存从网页返回的数据,然后通过自定义解析方法显示结果

我只是随便分析一下。如果我想非常准确地分析它,我需要再次处理它

分析结果如下:

capturehtml()的结果:

查询结果[1]:111. 142. 55.73==>;1871591241==>;福建省漳州移动

二、grab在网页上获取JavaScript返回的结果

有时网站为了保护自己的数据,它不直接在web源代码中返回数据,而是使用JS异步方式返回数据,这样可以避免搜索引擎等工具捕获网站数据

首先看一下这一页:

第一种方式是查看网页的源代码,但是找不到运单的跟踪信息,因为它是通过JS获得结果的

但有时我们需要获取JS数据。此时我们应该做什么

此时,我们需要使用一个工具:http analyzer,它可以拦截http的交互内容。我们使用这个工具来实现我们的目的

首先,单击开始按钮后,它开始监听web页面的交互

当我们打开网页:,我们可以看到HTTP analyzer列出了该网页的所有请求数据和结果:

为了更方便的查看JS的结果,我们先清除这些数据,然后在网页中输入快递订单号:7,点击查询按钮,然后查看HTTP analyzer的结果:

这是HTTP analyzer点击查询按钮后的结果,我们继续查看:

从上面两幅图可以看出,HTTP analyzer可以截获JS返回的数据并显示在响应内容中,同时可以看到JS请求的网页地址

在这种情况下,我们可以通过分析HTTP analyzer的结果,模拟JS的行为来获取数据,即我们只需要访问JS请求的网页地址就可以获取数据,当然前提是这些数据没有加密,我们写下JS请求的URL:

然后让程序请求此网页的结果

代码如下:

[爪哇]

publicvoidcaptureJavascript(Stringpostid)通过异常{StringstrURL=“”+postid+”&;channel=&;rnd=0;URLurl=newURL(strURL);HttpURLConnectionhttpConn=(HttpURLConnection)url.openConnection();InputStreamReaderinput=newInputStreamReader(httpConn.getInputStream(),“utf-8”);BufferedReaderBufferReader=NewBuffereder(input);Stringline=”“stringbuildercontentbuf=newstringbuilder();while((line=bufrader.Readline())!=null){contentbuf.Append(line);}system.out.println(“capturejavascript()的结果:\n”+contentbuf.Tostring());”

就像两颗豌豆一样。抓取JS的方法与我们抓取原创页面的代码完全相同。我们只是做了一个分析JS的过程

以下是程序执行的结果:

capturejavascript()的结果:

运单跟踪信息[7]

这些数据是JS返回的结果,我们的目标已经实现了

希望本文能帮助有需要的朋友。如果您需要该程序的源代码,请点击这里下载 查看全部

实时抓取网页数据(本文就用Java给大家演示如何抓取网站的数据:(1))

原创链接:

有时,由于各种原因,我们需要采集a网站data,但由于网站data的不同,数据的显示方式略有不同

本文将使用java向您展示如何抓取网站数据:(1)抓取原创网页数据;(2)抓取网页JavaScript返回的数据)

一、抓取原创网页

在本例中,我们将从以下位置获取IP查询的结果:

步骤1:打开此页面并输入IP:111. 142. 55.73.点击查询按钮查看网页上显示的结果:

第二步:查看web源代码。我们可以看到源代码中有一段:

从这里可以看出,查询结果是在重新请求网页后显示的

我们来看看查询后的网址:

换言之,只要访问这样的网站,我们就可以得到IP查询的结果。接下来,看看代码:

[爪哇]

publicvoidcaptureHtml(Stringip)throwsException{StringstrURL=”“+ip;URLurl=newURL(strURL);HttpURLConnectionhttpConn=(HttpURLConnection)url.openConnection();InputStreamReaderinput=newInputStreamReader(httpConn.getInputStream(),“utf-8”);BufferedReaderBufferer=newBufferedReader(input);Stringline=“;StringBuilderContentBuff=newStringBuilder();while((line=bufrader.Readline())!=null){contentbuf.Append(line);}stringbuf=contentbuf.Tostring();intbeginix=buf.Indexof(“查询结果[”);intendix=buf.Indexof(“依次显示上述四项”);stringresult=buf.Substring(beginix,endix);system.Out.Println(“capturehtml的结果():“n”+结果”);}

使用httpurlconnection连接到网站,使用bufreader保存从网页返回的数据,然后通过自定义解析方法显示结果

我只是随便分析一下。如果我想非常准确地分析它,我需要再次处理它

分析结果如下:

capturehtml()的结果:

查询结果[1]:111. 142. 55.73==>;1871591241==>;福建省漳州移动

二、grab在网页上获取JavaScript返回的结果

有时网站为了保护自己的数据,它不直接在web源代码中返回数据,而是使用JS异步方式返回数据,这样可以避免搜索引擎等工具捕获网站数据

首先看一下这一页:

第一种方式是查看网页的源代码,但是找不到运单的跟踪信息,因为它是通过JS获得结果的

但有时我们需要获取JS数据。此时我们应该做什么

此时,我们需要使用一个工具:http analyzer,它可以拦截http的交互内容。我们使用这个工具来实现我们的目的

首先,单击开始按钮后,它开始监听web页面的交互

当我们打开网页:,我们可以看到HTTP analyzer列出了该网页的所有请求数据和结果:

为了更方便的查看JS的结果,我们先清除这些数据,然后在网页中输入快递订单号:7,点击查询按钮,然后查看HTTP analyzer的结果:

这是HTTP analyzer点击查询按钮后的结果,我们继续查看:

从上面两幅图可以看出,HTTP analyzer可以截获JS返回的数据并显示在响应内容中,同时可以看到JS请求的网页地址

在这种情况下,我们可以通过分析HTTP analyzer的结果,模拟JS的行为来获取数据,即我们只需要访问JS请求的网页地址就可以获取数据,当然前提是这些数据没有加密,我们写下JS请求的URL:

然后让程序请求此网页的结果

代码如下:

[爪哇]

publicvoidcaptureJavascript(Stringpostid)通过异常{StringstrURL=“”+postid+”&;channel=&;rnd=0;URLurl=newURL(strURL);HttpURLConnectionhttpConn=(HttpURLConnection)url.openConnection();InputStreamReaderinput=newInputStreamReader(httpConn.getInputStream(),“utf-8”);BufferedReaderBufferReader=NewBuffereder(input);Stringline=”“stringbuildercontentbuf=newstringbuilder();while((line=bufrader.Readline())!=null){contentbuf.Append(line);}system.out.println(“capturejavascript()的结果:\n”+contentbuf.Tostring());”

就像两颗豌豆一样。抓取JS的方法与我们抓取原创页面的代码完全相同。我们只是做了一个分析JS的过程

以下是程序执行的结果:

capturejavascript()的结果:

运单跟踪信息[7]

这些数据是JS返回的结果,我们的目标已经实现了

希望本文能帮助有需要的朋友。如果您需要该程序的源代码,请点击这里下载

实时抓取网页数据(如何快速地从网站上来获取自己需要的数据哦! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 336 次浏览 • 2021-09-19 06:13

)

有时候我们制作excel表格时,很多数据源可能来自互联网,所以我们需要从网站下载数据供我们使用,或者我们需要手动逐个输入。。。但这太麻烦了。今天,我们将教您一种从网站快速获取所需数据的方法!我想记得采集

操作步骤:

1.首先,我们打开一个网站,找到我们想要的数据,然后首先复制网站的链接。这里我们选择个人所得税税率表。我们希望捕获网页上表的内容

2.然后打开excel表格,单击数据-来自网站,将弹出一个新的web查询对话框

然后在地址栏中粘贴刚才复制的网站连接。然后选择[go]自动跳转到数据界面的网站

3.然后在“新建web查询”对话框中单击所需表格的箭头按钮,然后单击右下角的“导入”。完成此操作后,我们需要的数据将添加到excel表中

4.当您想要导入数据时,您可以选择数据的位置或数据的起始位置,或者创建一个新的工作表。选择后,单击“确定”

通过这种方式,您可以看到网站In中的数据一次添加到excel表中。请注意,如果数据量很大,导入可能会很慢,但最终,您可以轻松地获取网站数据

最后,您可以使用[apply table style]稍微美化一下桌子,这样就可以了~

最终效果:

下面是另一个供您观看的动态图片演示。如果你不明白,你可以看看这里

好的~以上是关于如何从网页中获取数据的提示。经常需要在互联网上采集数据的朋友希望能帮助你。如果有用,请喜欢,转发和采集!补充

查看全部

实时抓取网页数据(如何快速地从网站上来获取自己需要的数据哦!

)

有时候我们制作excel表格时,很多数据源可能来自互联网,所以我们需要从网站下载数据供我们使用,或者我们需要手动逐个输入。。。但这太麻烦了。今天,我们将教您一种从网站快速获取所需数据的方法!我想记得采集

操作步骤:

1.首先,我们打开一个网站,找到我们想要的数据,然后首先复制网站的链接。这里我们选择个人所得税税率表。我们希望捕获网页上表的内容

2.然后打开excel表格,单击数据-来自网站,将弹出一个新的web查询对话框

然后在地址栏中粘贴刚才复制的网站连接。然后选择[go]自动跳转到数据界面的网站

3.然后在“新建web查询”对话框中单击所需表格的箭头按钮,然后单击右下角的“导入”。完成此操作后,我们需要的数据将添加到excel表中

4.当您想要导入数据时,您可以选择数据的位置或数据的起始位置,或者创建一个新的工作表。选择后,单击“确定”

通过这种方式,您可以看到网站In中的数据一次添加到excel表中。请注意,如果数据量很大,导入可能会很慢,但最终,您可以轻松地获取网站数据

最后,您可以使用[apply table style]稍微美化一下桌子,这样就可以了~

最终效果:

下面是另一个供您观看的动态图片演示。如果你不明白,你可以看看这里

好的~以上是关于如何从网页中获取数据的提示。经常需要在互联网上采集数据的朋友希望能帮助你。如果有用,请喜欢,转发和采集!补充

实时抓取网页数据( Python查看股市信息太过招摇决定Python抓取相关信息小巧便捷)

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-10-04 09:36

Python查看股市信息太过招摇决定Python抓取相关信息小巧便捷)

Python爬取网页数据python爬取网页数据txt51自信是取之不尽的源泉自信是无尽的波浪,自信是快速进步的通道,自信是成功之母,用python爬取网页并处理它们 2009-02- 19150950 Category Python tag no font size subscription 主要目的是抓取网页的源代码,处理其中需要的数据,并保存到数据库中。它已实现抓取页面并读取数据。第一步抓取页面。这一步很简单,引入 urllib 使用 urlopen 打开 URL,使用 read 方法读取数据。为了方便测试,使用本地文本文件,而不是抓取网页。第二步。处理数据。如果页面代码更加规范和规范,可以使用HTMLParser进行简单处理,但具体情况需要具体分析。最好使用常规规则。顺便练习一下刚学的正则表达式。其实正则表达式也是一种比较简单的语言。符号比较晦涩难懂。它只能是更多的练习和练习。Step 3 将处理后的数据保存到数据库中,使用pymssql进行处理。只需将其保存到文本文件并扩展即可。使用此功能,您还可以捕获整个 网站 图像并自动声明站点地图文件。接下来的任务是研究python的socket函数 --codinggbk--importurllibimportrepagerurlliburlopendatapagerreadpagerclosefopenr"D2txt"datafreadfclose 处理数据预编译classonedivreIreSmpfindalldatas"

链接地址 p_titlerecompileh2h2reIreSp_urlrecompilehref"reIreSp_summarrecompileppreIreSp_imagerecompileeshopimages"reIreSss" title "p_titlesearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup51327n""介绍"p_summarsearchdatangroup51327n" 的相关脚本也决定了将python的相关信息写入脚本中信息。它小巧方便。1 先写一个Python脚本抓取股市查询页面。这很简单。我发现个股的实时行情数据是写在一个javascript文件里的。2 Extract this 编写javascript文件URL,编写一个Python脚本来抓取文件,读取其内容,做字符串处理,提取股价上涨等信息。以“股票代码js”形式解析文件名创建配置文件,提供感兴趣的股票代码。使用 Python 脚本读取配置信息。定期阅读所需的实时信息。5 定义每日市场格式并将其存储为 XML 格式。脚本实现读取存储的行情信息,生成报表K线等图形信息 查看全部

实时抓取网页数据(

Python查看股市信息太过招摇决定Python抓取相关信息小巧便捷)

Python爬取网页数据python爬取网页数据txt51自信是取之不尽的源泉自信是无尽的波浪,自信是快速进步的通道,自信是成功之母,用python爬取网页并处理它们 2009-02- 19150950 Category Python tag no font size subscription 主要目的是抓取网页的源代码,处理其中需要的数据,并保存到数据库中。它已实现抓取页面并读取数据。第一步抓取页面。这一步很简单,引入 urllib 使用 urlopen 打开 URL,使用 read 方法读取数据。为了方便测试,使用本地文本文件,而不是抓取网页。第二步。处理数据。如果页面代码更加规范和规范,可以使用HTMLParser进行简单处理,但具体情况需要具体分析。最好使用常规规则。顺便练习一下刚学的正则表达式。其实正则表达式也是一种比较简单的语言。符号比较晦涩难懂。它只能是更多的练习和练习。Step 3 将处理后的数据保存到数据库中,使用pymssql进行处理。只需将其保存到文本文件并扩展即可。使用此功能,您还可以捕获整个 网站 图像并自动声明站点地图文件。接下来的任务是研究python的socket函数 --codinggbk--importurllibimportrepagerurlliburlopendatapagerreadpagerclosefopenr"D2txt"datafreadfclose 处理数据预编译classonedivreIreSmpfindalldatas"

链接地址 p_titlerecompileh2h2reIreSp_urlrecompilehref"reIreSp_summarrecompileppreIreSp_imagerecompileeshopimages"reIreSss" title "p_titlesearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup"rn""介绍"p_summarsearchdatangroup51327n""介绍"p_summarsearchdatangroup51327n" 的相关脚本也决定了将python的相关信息写入脚本中信息。它小巧方便。1 先写一个Python脚本抓取股市查询页面。这很简单。我发现个股的实时行情数据是写在一个javascript文件里的。2 Extract this 编写javascript文件URL,编写一个Python脚本来抓取文件,读取其内容,做字符串处理,提取股价上涨等信息。以“股票代码js”形式解析文件名创建配置文件,提供感兴趣的股票代码。使用 Python 脚本读取配置信息。定期阅读所需的实时信息。5 定义每日市场格式并将其存储为 XML 格式。脚本实现读取存储的行情信息,生成报表K线等图形信息

实时抓取网页数据( 网络中获取网页数据的案例代码postedon2011-05-31)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2021-10-03 04:01

网络中获取网页数据的案例代码postedon2011-05-31)

十六、从网上获取网页数据

从网络获取网页数据时,网页可以使用GZIP压缩技术对网页进行压缩,这样可以减少网络传输的数据量,提高浏览速度。所以获取网络数据时需要判断,并使用GZIPInputStream对GZIP格式数据进行特殊处理,否则获取数据时可能出现乱码。

以下是获取网络中网页数据的案例代码

package com.ljq.test;

import java.io.ByteArrayOutputStream;

import java.io.InputStream;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.zip.GZIPInputStream;

import java.util.zip.GZIPOutputStream;

/**

* 从网络中获取网页数据

*

* @author jiqinlin

*

*/

public class InternetTest2 {

@SuppressWarnings("static-access")

public static void main(String[] args) throws Exception {

String result = "";

//URL url = new URL("http://www.sohu.com");

URL url = new URL("http://www.ku6.com/");

HttpURLConnection conn = (HttpURLConnection) url.openConnection();

conn.setConnectTimeout(6* 1000);//设置连接超时

if (conn.getResponseCode() != 200) throw new RuntimeException("请求url失败");

InputStream is = conn.getInputStream();//得到网络返回的输入流

if("gzip".equals(conn.getContentEncoding())){

result = new InternetTest2().readDataForZgip(is, "GBK");

}else {

result = new InternetTest2().readData(is, "GBK");

}

conn.disconnect();

System.out.println(result);

System.err.println("ContentEncoding: " + conn.getContentEncoding());

}

//第一个参数为输入流,第二个参数为字符集编码

public static String readData(InputStream inSream, String charsetName) throws Exception{

ByteArrayOutputStream outStream = new ByteArrayOutputStream();

byte[] buffer = new byte[1024];

int len = -1;

while( (len = inSream.read(buffer)) != -1 ){

outStream.write(buffer, 0, len);

}

byte[] data = outStream.toByteArray();

outStream.close();

inSream.close();

return new String(data, charsetName);

}

//第一个参数为输入流,第二个参数为字符集编码

public static String readDataForZgip(InputStream inStream, String charsetName) throws Exception{

GZIPInputStream gzipStream = new GZIPInputStream(inStream);

ByteArrayOutputStream outStream = new ByteArrayOutputStream();

byte[] buffer =new byte[1024];

int len = -1;

while ((len = gzipStream.read(buffer))!=-1) {

outStream.write(buffer, 0, len);

}

byte[] data = outStream.toByteArray();

outStream.close();

gzipStream.close();

inStream.close();

return new String(data, charsetName);

}

}

发表于 2011-05-31 15:40 无情阅读(3891)评论(2)编辑 查看全部

实时抓取网页数据(

网络中获取网页数据的案例代码postedon2011-05-31)

十六、从网上获取网页数据

从网络获取网页数据时,网页可以使用GZIP压缩技术对网页进行压缩,这样可以减少网络传输的数据量,提高浏览速度。所以获取网络数据时需要判断,并使用GZIPInputStream对GZIP格式数据进行特殊处理,否则获取数据时可能出现乱码。

以下是获取网络中网页数据的案例代码

package com.ljq.test;

import java.io.ByteArrayOutputStream;

import java.io.InputStream;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.zip.GZIPInputStream;

import java.util.zip.GZIPOutputStream;

/**

* 从网络中获取网页数据

*

* @author jiqinlin

*

*/

public class InternetTest2 {

@SuppressWarnings("static-access")

public static void main(String[] args) throws Exception {

String result = "";

//URL url = new URL("http://www.sohu.com";);

URL url = new URL("http://www.ku6.com/";);

HttpURLConnection conn = (HttpURLConnection) url.openConnection();

conn.setConnectTimeout(6* 1000);//设置连接超时

if (conn.getResponseCode() != 200) throw new RuntimeException("请求url失败");

InputStream is = conn.getInputStream();//得到网络返回的输入流

if("gzip".equals(conn.getContentEncoding())){

result = new InternetTest2().readDataForZgip(is, "GBK");

}else {

result = new InternetTest2().readData(is, "GBK");